- 投稿日:2019-05-27T23:58:56+09:00

DataFrame や Series内のデータ参照は「iat」で行おう

はじめに

こんにちは。

現在東京大学で主にシステムデザインを学んでいる学生です。

授業で少し大きめのデータを扱った際に普段より長い処理時間に苦労したので、その時に試したちょっとした高速化の工夫をご紹介したいと思います。用意したDataFrame

名前:Data

長さ:10**6

カラム:ITEM, NUM (適当に作った為、特に意味の無いデータです)>>> Data.head() ITEM NUM 0 02134 1 1 04137 1 2 03900 1 3 00792 1 4 03678 1 >>> print(len(Data)) 1000000メソッドごとの処理時間の比較

ただデータにアクセスするだけの処理を行い、掛かった時間を比較しています。

1. メソッドを用いない場合(カラム名、インデックスで直接指定)

t = time.time() for i in range(len(Data)): Data['NUM'][i] print(time.time()-t) # 54.226483583450322.

.ilocを用いた場合t = time.time() for i in range(len(Data)): Data.iloc[i,1] print(time.time()-t) # 16.671371221542363.

.iatを用いた場合t = time.time() for i in range(len(Data)): Data.iat[i,1] print(time.time()-t) # 10.457467794418335結果

それぞれの処理時間をまとめると以下のようになりました。

メソッド データ数 処理時間(s) 無 10^6 54.23 iloc 10^6 16.67 iat 10^6 10.46 感想

10^6 程の大きさのデータに対してもこれだけの差が出るとは思っていなかった為、少々驚きました。

大きめのデータを扱う際にはPythonのライブラリのメソッドを積極的に活用していきたいと思います。

- 投稿日:2019-05-27T23:17:30+09:00

最新機械学習モデル HistGradientBoostingTreeの性能調査(LightGBMと比較検証)

Abstract

ヒストグラムベースのGradientBoostingTreeが追加されたので、系譜のLightGBMと比較した使用感を検証する。

今回はハイパーパラメータ探索のOptunaを使い、パラメータ探索時点から速度や精度を比較検証する。

最後にKaggleにSubmissionして、汎用性を確認する。Introduction

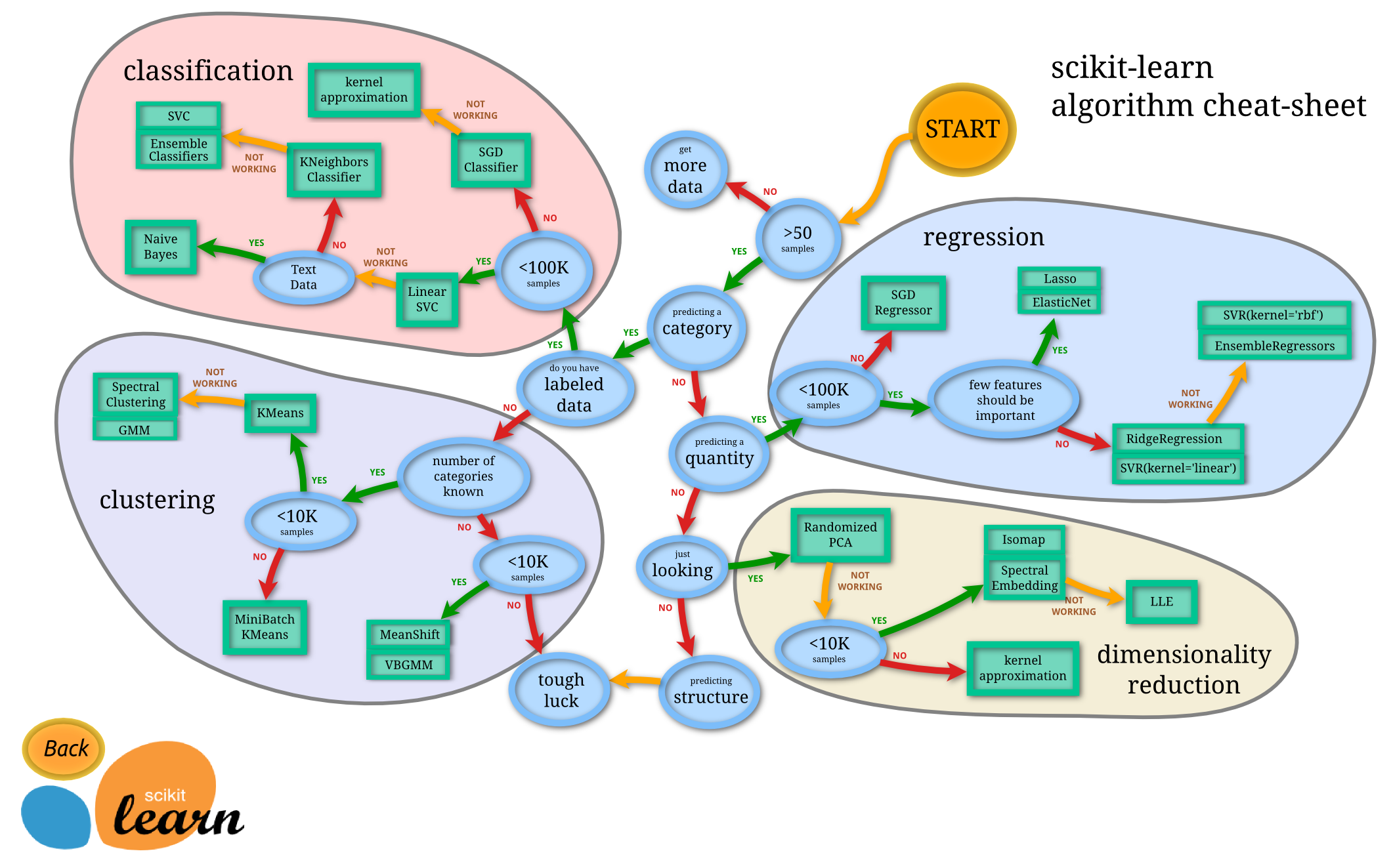

scikit-learn v0.21 で追加された HistGradientBoosting*

ヒストグラムベースの勾配ブースティング木。LightGBMの系譜。n_samples >= 10,000 のデータセットの場合、sklearn.ensemble.GradientBoostingClassifierよりもずっと高速に動く。

LightGBMと同じくbinning(整数で値を分割)しているので高速且つ、汎用性が高いものになっている。

Environment

検証環境

PC環境

OS: macOS HighSierra 10.13.6(Retina, Early 2015) CPU: 3.1GHz Intel Core i7 MEM: 16GB 1867MHz DDR3 GPU: Intel Iris Graphics 6100 1536MB開発環境

Python==3.6.8 jupyter notebookimport numpy as np import pandas as pd import lightgbm as lgbm import seaborn as sns import matplotlib.pyplot as plt %matplotlib inline import warnings warnings.filterwarnings('ignore') from IPython.core.interactiveshell import InteractiveShell InteractiveShell.ast_node_interactivity = 'all' %reload_ext autoreload %autoreload 2HistGradientBoostingTree インストール

1.Scikit-learnを0.21.*以上にする必要性がある

!pip install -U scikit-learn==0.21.02.ライブラリをインポート

import sklearn sklearn.__version__ '0.21.0'3.現状では、from sklearn.experimental import enable_hist_gradient_boostingを一緒にインポートする必要性がある

from sklearn.experimental import enable_hist_gradient_boosting from sklearn.ensemble import HistGradientBoostingClassifier速度計測

import time from contextlib import contextmanager @contextmanager def timer(name): t0 = time.time() yield study, params, value print(f'[{name}] done in {time.time() - t0:.0f} s') print(f'[params]: \n{params}') print(f'[value]: {value}')データ

Titanic: Machine Learning from Disaster

適度なデータ数、カーディナリティの少なさ、解釈しやすさ、皆に認識されてる3点から採用。

このコンペは、タイタニック号に乗船した、各乗客の購入したチケットのクラス(Pclass1, 2, 3の順で高いクラス)や、料金(Fare)、年齢(Age)、性別(Sex)、出港地(Embarked)、部屋番号(Cabin)、チケット番号(Tichket)、乗船していた兄弟または配偶者の数(SibSp)、乗船していた親または子供の数(Parch)など情報があり、そこからタイタニック号が氷山に衝突し沈没した際生存したかどうか(Survived)を予測する。

変数名 特徴 PassengerId 乗客識別ユニークID Survived 生死 Pclass チケットクラス Name 乗客の名前 Sex 性別 Age 年齢 SibSp タイタニックに同乗している兄弟/配偶者の数 Parch タイタニックに同乗している親/子供の数 Ticket チケット番号 Cabin 客室番号 Embarked 出港地(タイタニックへ乗った港) 前処理

前処理の方針としては、カテゴリ変数を数値型に変換し、欠損値をLightGBMで予測して埋める、のみ。

train = pd.read_csv('train.csv') test = pd.read_csv('test.csv') # 欠損値を見ていくとAge, Cabin, Embarked, Fareがあることがわかる。 train.isnull().sum() test.isnull().sum() # Name, Sex, Ticket, Cabin, Embarkedのデータ型はObject型なのがわかる # 機械学習モデルを適用するために、数値型に変換する train.dtypes test.dtypes # Object型のName, Ticket, Cabinはカーディナリティが高く変換しづらいので削除 train = train.drop(['Name', 'Ticket', 'Cabin'], axis=1) test = test.drop(['Name', 'Ticket', 'Cabin'], axis=1) # Object型のEmbarked, Sexはカーディナリティが低く、変換しやすい数値データに変換 import category_encoders object_columns = ['Embarked', 'Sex'] encode = category_encoders.OrdinalEncoder(cols=object_columns, handle_unknown='impute') train = encode.fit_transform(train) test = encode.fit_transform(test) # NaNが4に割り振られているものを修正 #encode.category_mapping #encoded_train['Embarked'].value_counts() train['Embarked'].replace(4, np.nan, inplace=True) #encoded_train.isnull().sum() # Fare欠損値埋め # 予測したいデータ fare_null = test[test['Fare'].isnull()].drop(['Fare'], axis=1) # トレーニングデータ fare_X = test[~test['Fare'].isnull()].drop(['Fare'], axis=1) fare_y = test[~test['Fare'].isnull()]['Fare'] params = { 'boosting_type': 'gbdt', 'objective': 'regression_l2', 'metric': 'l2', 'num_leaves': 40, 'learning_rate': 0.05, 'feature_fraction': 0.9, 'bagging_fraction': 0.8, 'bagging_freq': 5, 'lambda_l2': 2, } fare_pred = lgbm.LGBMRegressor(**params).fit(fare_X, fare_y).predict(fare_null) test['Fare'].replace(np.nan, int(fare_pred), inplace=True) # Age欠損値埋め # 予測したいデータ age_null = pd.concat([ train[train['Age'].isnull()], test[test['Age'].isnull()] ]).drop(['Survived', 'Age'], axis=1) age_null_train = train[train['Age'].isnull()].drop(['Survived', 'Age'], axis=1) age_null_test = test[test['Age'].isnull()].drop(['Age'], axis=1) # トレーニングデータ age_X = pd.concat([ train[~train['Age'].isnull()], test[~test['Age'].isnull()] ]).drop(['Survived','Age'], axis=1) age_y = pd.concat([ train[~train['Age'].isnull()], test[~test['Age'].isnull()] ])['Age'] params = { 'boosting_type': 'gbdt', 'objective': 'regression_l2', 'metric': 'l2', 'num_leaves': 40, 'learning_rate': 0.05, 'feature_fraction': 0.9, 'bagging_fraction': 0.8, 'bagging_freq': 5, 'lambda_l2': 2, } age_pred_train = lgbm.LGBMRegressor(**params).fit(age_X, age_y).predict(age_null_train) age_pred_test = lgbm.LGBMRegressor(**params).fit(age_X, age_y).predict(age_null_test) # 欠損値 nan = np.zeros(age_pred_train.shape[0]) nan[:] = np.nan train['Age'].replace(nan, age_pred_train.astype(np.float64), inplace=True) nan = np.zeros(age_pred_test.shape[0]) nan[:] = np.nan test['Age'].replace(nan, age_pred_test.astype(np.float64), inplace=True) # Embarked欠損値埋め # 予測したいデータ embarked_null = train[train['Embarked'].isnull()].drop(['Survived', 'Embarked'], axis=1) # トレーニングデータ embarked_X = train[~train['Embarked'].isnull()].drop(['Survived', 'Embarked'], axis=1) embarked_y = train[~train['Embarked'].isnull()]['Embarked'] params = { 'boosting_type': 'gbdt', 'objective': 'multiclass', 'num_class': 4, 'num_leaves': 40, 'learning_rate': 0.05, 'feature_fraction': 0.9, 'bagging_fraction': 0.8, 'bagging_freq': 5, 'lambda_l2': 2, } embarked_pred = lgbm.LGBMClassifier(**params).fit(embarked_X, embarked_y).predict(embarked_null) nan = np.zeros(embarked_pred.shape[0]) nan[:] = np.nan train['Embarked'].replace(nan, embarked_pred.astype(np.float64), inplace=True)機械学習をさせるために、トレーニングデータを説明変数と目的変数に分離する

X = train.drop(['Survived'], axis=1) y = train['Survived']Method

import optuna import lightgbm as lgbm from sklearn.model_selection import StratifiedKFold from sklearn.model_selection import cross_validate from sklearn.metrics import accuracy_score交差検証を5回、一度のイテレーションでoptunaの学習を100回試行させる

SEED = 0 NFOLDS = 5 NTRIAL = 100モデルのパラメータをoptunadeで設定

def tuning_parameter(trial, classifier): if classifier == 'LightGBM': params = {} params['objective'] = 'binary' params['random_state'] = SEED params['metric'] = 'binary_logloss' params['verbosity'] = -1 params['boosting_type'] = trial.suggest_categorical('boosting', ['gbdt', 'dart', 'goss']) # モデル訓練のスピードを上げる params['bagging_freq'] = 0 params['save_binary'] = False # 推測精度を向上させる params['learning_rate'] = trial.suggest_loguniform('learning_rate', 1e-8, 1.0) params['num_iterations'] = trial.suggest_int('num_iterations', 10, 1000) params['num_leaves'] = trial.suggest_int('num_leaves', 5, 1000) params['max_bins'] = trial.suggest_int('max_bins', 2, 256) # 過学習対策 # early stoppingは今回使わない。切り方によって、性能を高く見積もる可能性があるため。 # データ数が少ないため、早期に切り上げる必要性を感じないため。 params['min_data_in_leaf'] = trial.suggest_int('min_data_in_leaf', 10, 1000) params['feature_fraction'] = 1.0#feature * 0.01 params['bagging_fraction'] = trial.suggest_uniform('bagging_fraction', 0, 1.0) params['min_child_weight'] = trial.suggest_int('min_child_weight', 0, 1e-3) params['lambda_l1'] = trial.suggest_int('lambda_l1', 0, 500) params['lambda_l2'] = trial.suggest_int('lambda_l2', 0, 500) params['min_gain_to_split'] = 0.0 params['max_depth'] = trial.suggest_int('max_depth', 6, 10) if params['boosting_type'] == 'dart': params['drop_rate'] = trial.suggest_loguniform('drop_rate', 1e-8, 1.0) params['skip_drop'] = trial.suggest_loguniform('skip_drop', 1e-8, 1.0) if params['boosting_type'] == 'goss': params['top_rate'] = trial.suggest_uniform('top_rate', 0.0, 1.0) params['other_rate'] = trial.suggest_uniform('other_rate', 0.0, 1.0 - params['top_rate']) return params if classifier == 'HistGradientBoostingClassifier': params = {} params['random_state'] = SEED params['loss'] = 'binary_crossentropy' params['verbose'] = -1 # モデル訓練のスピードを上げる params['tol'] = trial.suggest_loguniform('tol', 1e-8, 1e-1) # 推測精度を向上させる params['learning_rate'] = trial.suggest_loguniform('learning_rate', 1e-8, 1.0) params['max_iter'] = trial.suggest_int('max_iter', 10, 1000) params['max_leaf_nodes'] = trial.suggest_int('max_leaf_nodes', 5, 1000) params['max_bins'] = trial.suggest_int('max_bins', 2, 256) params['min_samples_leaf'] = trial.suggest_int('min_samples_leaf', 1, 100) # 過学習対策 params['max_depth'] = trial.suggest_int('max_depth', 6, 10) params['validation_fraction'] = 1.0 #feature * 0.01 params['l2_regularization'] = trial.suggest_int('l2_regularization', 0, 500) return paramsdef estimator(classifier, params): if classifier == 'LightGBM': return lgbm.LGBMClassifier(**params) if classifier == 'HistGradientBoostingClassifier': return HistGradientBoostingClassifier(**params)def evaluate_score(): return { 'accuracy': make_scorer(accuracy_score) }class Objective(object): def __init__(self, dataset): self.X, self.y = dataset['training'], dataset['answer'] def __call__(self, trial): classifier = dataset['classifier'] if 'classifier' in dataset else trial.suggest_categorical('classifier', ['LightGBM', 'HistGradientBoostingClassifier']) params = tuning_parameter(trial, classifier) clf = estimator(classifier, params) score = evaluate_score() kf = StratifiedKFold(n_splits=NFOLDS, shuffle=True, random_state=SEED) scores = cross_validate(estimator=clf, X=self.X, y=self.y, cv=kf, scoring=score, n_jobs=-1) return 1.0 - scores['test_accuracy'].mean()def bayesian_optimize_parameter(dataset): objective = Objective(dataset) study = optuna.create_study() study.optimize(objective, n_trials=NTRIAL) return study, study.best_params, study.best_valueResult

HistGradientBoostingTree

性能を見るために、下記コードを5回イテレートする

dataset = {'classifier': 'HistGradientBoostingClassifier', 'training': X, 'answer': y} with timer('HistGradientBoostingClassifier'): study, params, value = bayesian_optimize_parameter(dataset)LightGBM

性能を見るために、下記コードを5回イテレートする

dataset = {'classifier': 'LightGBM', 'training': X, 'answer': y} with timer('LightGBM'): study, params, value = bayesian_optimize_parameter(dataset)ハイパーパラメータ探索結果

HGB1 [HistGradientBoostingClassifier] done in 238 s [params] {'tol': 1.0935262659564037e-05,'learning_rate': 0.21843938001639163, 'max_iter': 832, 'max_leaf_nodes': 343, 'max_bins': 51, 'min_samples_leaf': 36, 'max_depth': 6, 'l2_regularization': 300} [value] 0.17171144487154533 HGB2 [HistGradientBoostingClassifier] done in 321 s [params] {'tol': 1.1107827067059412e-08, 'learning_rate': 0.12517792167214872, 'max_iter': 800, 'max_leaf_nodes': 861, 'max_bins': 62, 'min_samples_leaf': 41, 'max_depth': 9, 'l2_regularization': 85} [value] 0.17953253206713848 HGB3 [HistGradientBoostingClassifier] done in 367 s [params] {'tol': 6.896662261124894e-08, 'learning_rate': 0.14764781999824614, 'max_iter': 1000, 'max_leaf_nodes': 503, 'max_bins': 96, 'min_samples_leaf': 50, 'max_depth': 7, 'l2_regularization': 476} [value] 0.17954536991623837 HGB4 [HistGradientBoostingClassifier] done in 271 s [params] {'tol': 0.0024598056599173636, 'learning_rate': 0.9659403525328403, 'max_iter': 294, 'max_leaf_nodes': 585, 'max_bins': 155, 'min_samples_leaf': 30, 'max_depth': 7, 'l2_regularization': 377} [value] 0.17955164698610204 HGB5 [HistGradientBoostingClassifier] done in 478 s [params] {'tol': 0.0005293901246527085, 'learning_rate': 0.12635631912783424, 'max_iter': 865, 'max_leaf_nodes': 7, 'max_bins': 254, 'min_samples_leaf': 30, 'max_depth': 6, 'l2_regularization': 307} [value] 0.17618713753911197LGBM1 [LightGBM] done in 43 s [params] {'boosting': 'dart', 'learning_rate': 0.004137394958415602, 'num_iterations': 158, 'num_leaves': 759, 'max_bins': 111, 'min_data_in_leaf': 932, 'bagging_fraction': 0.1684261701192018, 'min_child_weight': 0, 'lambda_l1': 445, 'lambda_l2': 485, 'max_depth': 7, 'drop_rate': 0.0038674989023377714, 'skip_drop': 1.8097533524230508e-05} [value] 0.3838350910902135 LGBM2 [LightGBM] done in 34 s [params] {'boosting': 'gbdt', 'learning_rate': 0.004745373948180777, 'num_iterations': 326, 'num_leaves': 642, 'max_bins': 205, 'min_data_in_leaf': 76, 'bagging_fraction': 0.23307801646070203, 'min_child_weight': 0, 'lambda_l1': 284, 'lambda_l2': 297, 'max_depth': 7} [value] 0.3838350910902135 LGBM3 [LightGBM] done in 27 s [params] {'boosting': 'dart', 'learning_rate': 4.9615250130452045e-08, 'num_iterations': 396, 'num_leaves': 313, 'max_bins': 212, 'min_data_in_leaf': 651, 'bagging_fraction': 0.5520979835666021, 'min_child_weight': 0, 'lambda_l1': 372, 'lambda_l2': 418, 'max_depth': 7, 'drop_rate': 0.033146741471333195, 'skip_drop': 2.5375076235227994e-06} [value] 0.3838350910902135 LGBM4 [LightGBM] done in 26 s [params] {'boosting': 'goss', 'learning_rate': 0.40258324836757814, 'num_iterations': 371, 'num_leaves': 516, 'max_bins': 68, 'min_data_in_leaf': 959, 'bagging_fraction': 0.0734967883663078, 'min_child_weight': 0, 'lambda_l1': 406, 'lambda_l2': 82, 'max_depth': 6, 'top_rate': 0.2811244648326302, 'other_rate': 0.3144101282050923} [value] 0.3838350910902135 LGBM5 [LightGBM] done in 31 s [params] {'boosting': 'dart', 'learning_rate': 0.0014181192774496755, 'num_iterations': 426, 'num_leaves': 41, 'max_bins': 62, 'min_data_in_leaf': 186, 'bagging_fraction': 0.8023598243375999, 'min_child_weight': 0, 'lambda_l1': 8, 'lambda_l2': 21, 'max_depth': 7, 'drop_rate': 0.3898994081662355, 'skip_drop': 0.006867493636822156} [value] 0.21320337316258287精度と速度

5回の交差検証と、100回のoptunaでのパラメータ探索、それらを5セットずつ行い、最高精度と最良パラメータを抽出した

KaggleのSubmissionのScoreに合わせて1.0 - study.best_valueして精度を算出

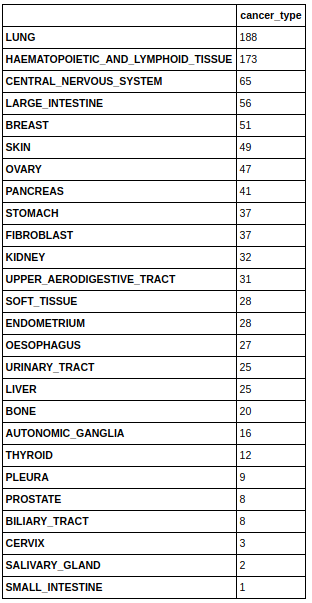

モデル1 モデル2 モデル3 モデル4 モデル5 HGB 0.82828 0.82046 0.82045 0.82044 0.82381 LGBM 0.61616 0.61616 0.61616 0.61616 0.78679

平均速度(秒/回) 最良速度(秒/回) 最低速度(秒/回) optuna平均精度 optuna 最良精度 optuna 最低精度 HGB 335 238 478 0.8227 0.82829 0.82382 LGBM 32 26 43 0.6503 0.7867 0.61617 LGBMの方が速度が10倍早く収束する。精度はHGBが平均して高い値を出している。最良精度も最低精度もHGBが高い値を出している。

また精度の振れ幅も少なく安定していると言えそう。パラメータ

精度向上

learning_rate: 0.316712(初期値0.1) max_iter: 758(初期値100)過学習対策

max_bins: 123(初期値255) tol: 0.0006(初期値1e-7=0.0000001) l2_regularization: 309(初期値0)不安要素

max_leaf_nodes: 459(初期値31) min_samples_leaf: 37(初期値20)全体: 過学習対策もきちんとなされていて汎用性があり、精度向上のパラメータも多めにしている。ただ、葉の最大枚数が多いので、ここの点のみ過学習が心配される。

精度向上: max_iterの値を見ると、初期値よりもじっくり学習するパラメータを選択している。

過学習対策: max_bins, tol, l2_regularizationの値が初期値よりも過学習対策に強く汎用性の高いパラメータを選んでそう。

不安要素: max_leaf_nodesが明らかにデータセットを鑑みた場合、多いので過学習である可能性を十分考慮する必要性がありそう。葉の枚数が多いということは、分割基準を細かく設定しているということになる為である。再学習

optunaで各々算出されたパラメータから、KaggleにSubmissionし、汎用性のあるモデルなのかどうかを検証する。

性能を見るために、下記コードを5回ずつイテレートするHistGradientBoostingTree

params = {'tol': 1.0935262659564037e-05, 'learning_rate': 0.21843938001639163, 'max_iter': 832, 'max_leaf_nodes': 343, 'max_bins': 51, 'min_samples_leaf': 36, 'max_depth': 6, 'l2_regularization': 300}prediction = HistGradientBoostingClassifier(**params).fit(X, y).predict(test)PassengerId = pd.read_csv('test.csv')['PassengerId'] HistGradientBoostingSubmission = pd.DataFrame({ 'PassengerId': PassengerId, 'Survived': prediction }) HistGradientBoostingSubmission.to_csv('HistGradientBoosting.csv', index=False)LightGBM

params = {'boosting': 'dart', 'learning_rate': 0.004137394958415602, 'num_iterations': 158, 'num_leaves': 759, 'max_bins': 111, 'min_data_in_leaf': 932, 'bagging_fraction': 0.1684261701192018, 'min_child_weight': 0, 'lambda_l1': 445, 'lambda_l2': 485, 'max_depth': 7, 'drop_rate': 0.0038674989023377714, 'skip_drop': 1.8097533524230508e-05}prediction = lgbm.LGBMClassifier(**params).fit(X, y).predict(test)PassengerId = pd.read_csv('test.csv')['PassengerId'] LightGBMSubmission = pd.DataFrame({ 'PassengerId': PassengerId, 'Survived': prediction }) LightGBMSubmission.to_csv('LightGBM.csv', index=False)Kaggleの本番テストデータで検証

モデル1 モデル2 モデル3 モデル4 モデル5 HGB 0.77033 0.77511 0.74641 0.76555 0.76555 LGBM 0.62679 0.62679 0.62679 0.62679 0.76555

Submission 平均精度 Submission最良精度 Submission最低精度 HGB 0.76459 0.77511 0.74641 LGBM 0.654542 0.76555 0.62679 HistGradientBoostingの方はoptuna検証時の82%の精度から77%の正解率が落ち、多少過学習気味だが高いスコアを出している。逆にLightGBMはoptuna検証時61%だったのに対して、65%と正解率が上昇していて汎用的なモデルが作成できている。ただ、HGBとLGBMを比較すると、12%もの精度の差が出た。

discussion

- Scikit-learnの決定木(Decision Tree)などとパラメータが似ているので触りやすい

- 最低限のパラメータで作られていて、過学習に対してのものが多い印象を受ける

- 今回のデータに対しては、Early Stoppingが正しくないと思ったのでしなかったが、その場合LightGBMと比較すると大分遅い

- 思った以上に高精度を叩き出し、ある程度適当なパラメーターでも安定して良いモデルが作成できそう

- 本来LightGBM系譜の純正sklearnということで精度そこそこ速度高速というのでGBT系のベンチマーク(optunaで回してデータに適合する共通のパラメタ探索用)として使えるかも!と思って触ったため、optunaで検証してみたがあてがはずれた

- 低速度、高精度、と意外な結果だが、これだとLightGBMというよりXGBoostやCatBoostと比較検証したほうが良さそう

- 大規模なデータセット(n_samples >= 10,000)に対しての精度と速度の検証をする必要性がありFeature Workとする

- モデル作成時間に関しては、どちらもHGBもLGBMもデータセットが軽く1秒以内に作成できたため非掲載

Referances

- 投稿日:2019-05-27T23:11:17+09:00

ArxivのDeep Learning関連論文を被引用数順に1000本並べてみる

Deep Learning関連の最新の論文をピックアップする方法ではなく、抄読会で取り上げるような目的で「のちの研究に大きな影響を与えた論文」を網羅的に探す方法が欲しかったため、論文を被引用数順に並べたリストの作成を試みた。

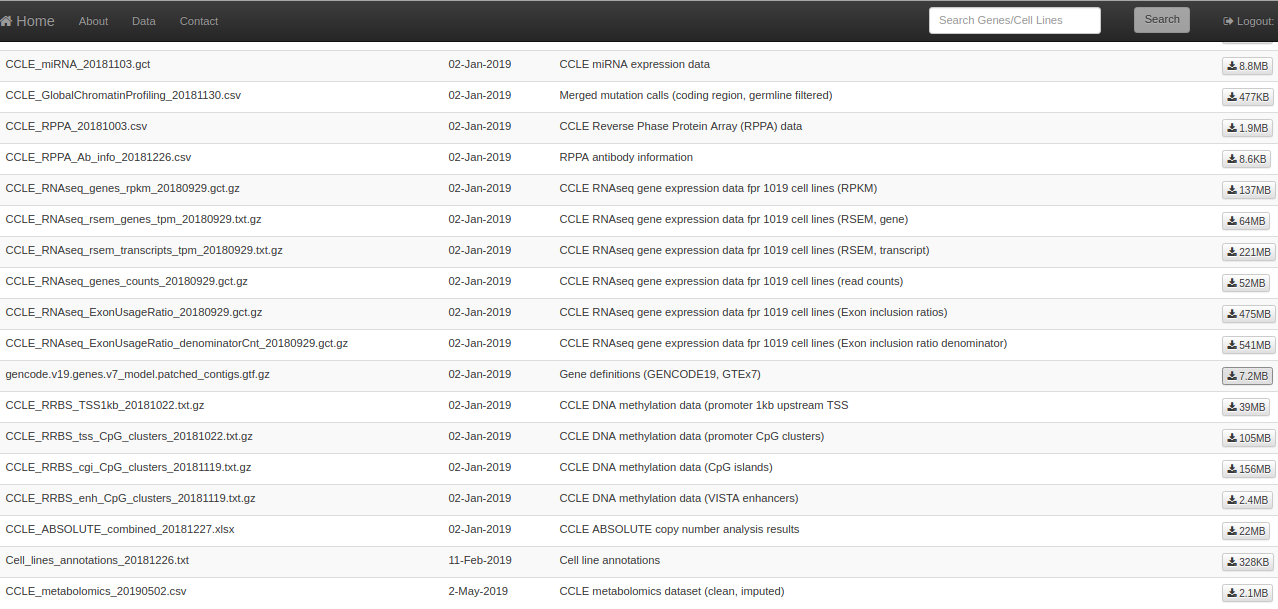

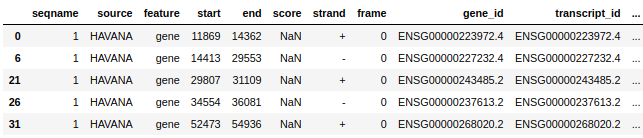

下記のコードで15000本の論文情報をArxivから取得してSemantic ScholarのAPIで被引用数を取得 (取得日は2019年5月27日)。import arxiv import pandas as pd import requests result = arxiv.query(search_query="all:deep learning") data = pd.DataFrame(columns = ["title","id",'arxiv_url','published']) for i in range(len(result)): id = result[i]['id'].split("/")[-1].split("v")[0] title = result[i]['title'] arxiv_url = result[i]['arxiv_url'] published = result[i]['published'] data_tmp = pd.DataFrame({"title":title,"id":id, "arxiv_url":arxiv_url, "published":published},index=[0]) data = pd.concat([data,data_tmp]).reset_index(drop=True) citation_num_list = [] for i in data["id"]: try: sem = requests.get("https://api.semanticscholar.org/v1/paper/arXiv:"+i).json() citation_num = len(sem["citations"]) except: citation_num = 0 citation_num_list.append(citation_num) data["citation"] = citation_num_list data = data.sort_values(by='citation', ascending=False) data.to_csv("data.csv",index=False)被引用数999以上は999+となって具体的な数値が得られなかったため結局手入力(30ちょいほどあった)。APIが不安定な挙動をするため、被引用数が取得できなかったレコードには0を割り当てており、そのために上位に出てこない論文があるので完璧なリストではない。

実際のところArxivのwebページでDeep Learningで検索すると16000ほど論文が引っかかってくるが、APIで得られたのは15000本であったため、ここでも抜けがあると思われる。そもそも検索単語が"Deep Learning"だけでいいのかという問題もある。

15000本の論文を得たにも関わらず、トップのResNetが被引用数16101なので、これも拾いきれていない論文があることを示唆する結果となった (Arxiv外の論文にも多々引用されているのかもしれないが)。

*34位の論文は、APIで被引用数999+の結果が得られたが、Arxivページに被引用数が表示されず、具体的な数字が不明。以下、15000本の中の上位1000本の論文の結果を表示。