- 投稿日:2019-02-11T23:40:16+09:00

只今勉強中!機械学習 スカラー回帰の例:住宅価格の予想

スカラー回帰

前回は 只今勉強中!機械学習 多クラス分類の例:ニュース配信の分類 の演習をしました。多クラス単一ラベル分類では複数のラベルのうちの1つを予測する問題でした。

回帰問題はラベルを予想するのではなく連続値を予測します。たとえば過去の株価から明日の株価を予測したり、過去の気温から明日の気温を予測したりします。

※回帰とロジスティック回帰は異なることに注意。ロジスティック回帰は分類アルゴリズムに属する。住宅価格の予想

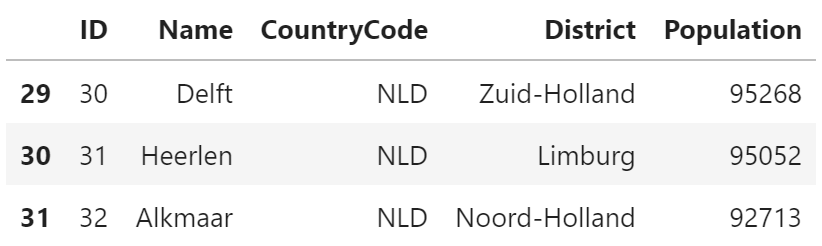

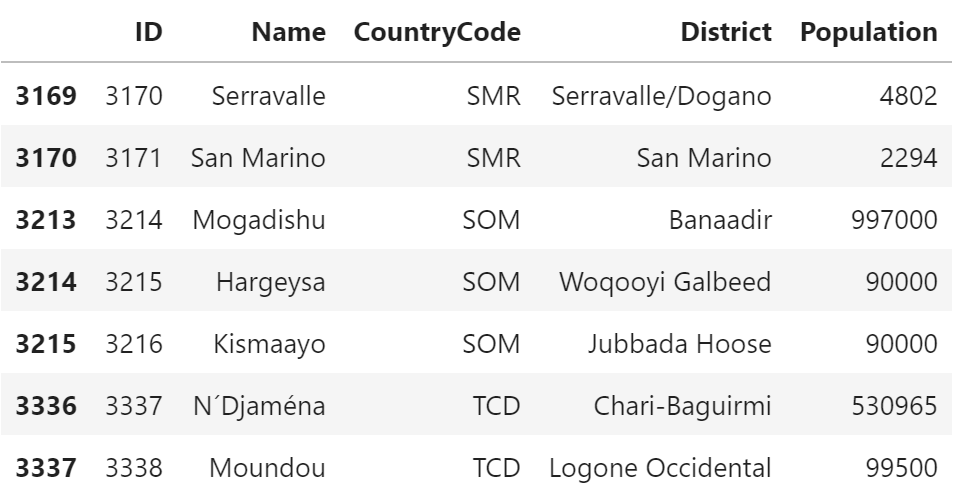

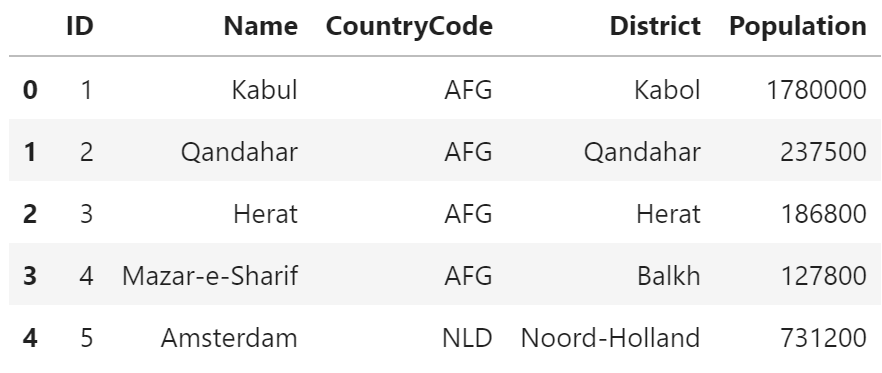

今回は1970年代中ごろのボストン近郊の住宅価格の中央値を予測する問題の演習をします。

予測データには部屋数や大きさ、犯罪発生率や税率などのデータ点が含まれています。

また、今回使用するデータ点は506個(404の訓練データと102個のテストデータ)しかなく、分類問題の時と比較して非常に少ないのが特徴的です。

入力データの特徴量はそれぞれ異なる尺度を使用(犯罪発生率、税率、部屋数など)している点も前回までの分類問題とは大きく異なる。サンプルデータを読み込む

tutorial.py# データ読み込み from keras.datasets import boston_housing (train_data, train_targets), (test_data, test_targets) = boston_housing.load_data() # データの確認 print(train_data.shape) >>> (404, 13) print(test_data.shape) >>> (102, 13) print(train_data[0]) >>> [ 1.23247 0. 8.14 0. 0.538 6.142 91.7 3.9769 4. 307. 21. 396.9 18.72 ]データの準備

特徴量のデータは価格や部屋の大きさ、部屋のタイプなど、値がバラバラなので正規化する必要がある

※正規化:価格も部屋の大きさも部屋のタイプも同じ基準の数値に揃えてあげる処理のこと

一般的に正規化で用いられる方法が「入力データを特徴量ごとに特徴量の平均値を引き、標準偏差で割る」である。tutorial.py# データを特徴量ごとに正規化する関数 def make_train_data(dataset, axis = 0): """ 特徴量ごとにデータを正規化する [手順] 入力データを特徴量ごとに特徴量の平均値を引き、標準偏差で割る -------- dataset:正規化するデータ axis :軸を指定(データが2次元配列なら0 #列が対象) """ mean = dataset.mean(axis) # 1軸目の平均値(2次配列なので各列の平均値) dataset -= mean # 平均値で引く std = dataset.std(axis) # 標準偏差 dataset /= std # 標準偏差で割る return dataset # 訓練でータを正規化 train_data = make_train_data(train_data, 0) # テストデータも正規化 test_data = make_train_data(test_data, 0)ニューラルネットワークの構築とモデルの定義

モデルを設計します。

レイヤー層のタイプ、出入力数、活性化関数のタイプ、そして層の数を設計します。

今回はモデルインスタンスを複数呼び出すk分割交差検証と呼ばれる方法を用いる為、model生成用の関数として定義し実装時に関数を呼び出すようにします。tutorial.py# モデルの定義 from keras import models from keras import layers """ MEA 平均絶対誤差(mean absolute error):予測値と目的地の誤差の絶対値の平均 """ def build_model(train_data): # モデルインスタンスを生成するメソッド model = models.Sequential() model.add(layers.Dense(64, activation='relu', input_shape=(train_data.shape[1],))) model.add(layers.Dense(64, activation='relu')) model.add(layers.Dense(1)) model.compile(optimizer='rmsprop', loss='mse', metrics=['mae']) return modelモデルの実装

k分割交差検証

- k分割交差検証とはデータセットをk個のサンプルセット(フォールド)に分割して、同じモデルのインスタンスもk個作成する。 k個のモデルをk-1個のサンプルセットでの訓練と1回の検証を行い、最後に検証スコアの平均を求める方法。 k値は4または5で行われることが多い。

tutorial.pyimport numpy as np # k分割交差検証データの生成 """ エポック数を500に増やし、エポックごとに検証ログを保存するようにして再訓練と検証を行う """ num_epochs = 500 k = 4 num_val_samples = len(train_data) // 4 # 小数点以下切り捨て all_mae_histories = [] for i in range(k): print('processing fold #', i) # 検証データの準備:フォールドiのデータ key = i * num_val_samples value = (i + 1) * num_val_samples val_data = train_data[key:value] val_targets = train_targets[key:value] # 訓練データの準備:残りのフォールドのデータ partial_train_data = np.concatenate( [ train_data[:key], train_data[value:] ], axis = 0 ) partial_train_targets = np.concatenate( [ train_targets[:key], train_targets[value:] ], axis = 0 ) # モデルインスタンスを取得 model = build_model(train_data) # モデルをサイレントモードで訓練と検証を実施 history = model.fit( partial_train_data, partial_train_targets, validation_data = (val_data, val_targets), epochs = num_epochs, batch_size = 1, verbose = 0 ) # i回目の平均絶対誤差を取得して格納 mea_history = history.history['val_mean_absolute_error'] all_mae_histories.append(mea_history) # k分割交差検証の平均スコアの履歴を作成 average_mae_history = [np.mean([x[i] for x in all_mae_histories]) for i in range(num_epochs)]i回目の(訓練、検証)出力ログ

processing fold # 0 processing fold # 1 processing fold # 2 processing fold # 3訓練(検証)データをプロット

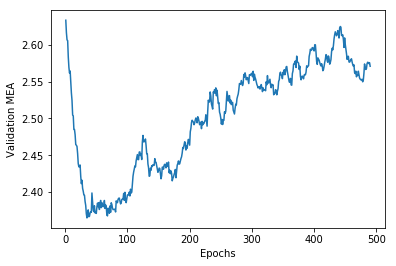

tutorial.py# 結果をプロット import matplotlib.pyplot as plt # このままだとグラフがみずらいので見やすくなるように修正 def smooth_curve(points, factor = 0.9): smoothed_points = [] for point in points: if smoothed_points: previous = smoothed_points[-1] smoothed_points.append(previous * factor + point * (1 - factor)) else: smoothed_points.append(point) return smoothed_points smoothed_mea_history = smooth_curve(average_mae_history[10:]) plt.plot(range(1, len(smoothed_mea_history) + 1), smoothed_mea_history) plt.xlabel('Epochs') plt.ylabel('Validation MEA') plt.show()データの検証

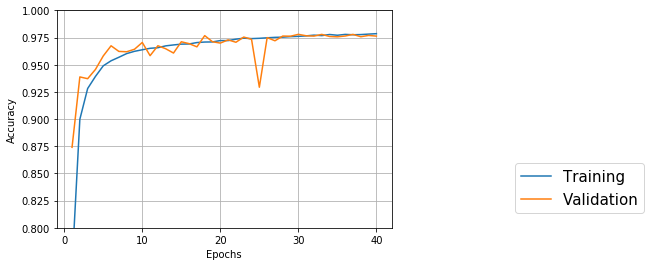

上記プロットから検証スコア(MEA=平均絶対誤差)が30エポック付近で大きく改善され、その後過学習に陥っていることが伺える。

ということでモデルをチューニングしてもう一度訓練を実施する。tutorial.pyimport numpy as np model = build_model(train_data) # モデルをサイレントモードでfit model.fit( train_data, train_targets, epochs = 30, batch_size = 8, verbose = 0 # サイレントモード ) # 検証スコアを取得 test_mse_score, test_mea_score = model.evaluate(test_data, test_targets) # 訓練結果出力 print(test_mea_score) >>> 2.7296556491477815振り返り

改めて30エポックでバッチサイズを8にして実行してみたが誤差は2700ほどと芳しくなかった。

この後、エポック数を調整していろいろ変えてみるも思わしい結果はでない。

本演習の目的は回帰問題のモデルの実装方法、そしてモデルのチューニング方法である。

モデルをチューニングするにあたって検証スコア(MEA=平均絶対誤差)をプロットし最小点を見つけ出すということがわかったので良しとする(肝心のテスト結果は芳しくないのだが、演習の教科書でも結果は思わしくないようである)。まとめ

- 回帰ではデータを正規化(一般的に正規化で用いられる方法が「入力データを特徴量ごとに特徴量の平均値を引き、標準偏差で割る」)する。

- 損失関数は、MSE(平均二乗誤差)を用いることが多い。

- 評価関数は、MEA(平均絶対誤差)を用いることが多い。

- 利用可能なデータが少ない場合はk分割交差検証を用いることが有効。

- 利用可能な訓練データが少ない場合は隠れ層の数を少ない(1か2)小さなネットワークを使用する。

- 投稿日:2019-02-11T22:52:20+09:00

ConoHaでDjango+Wagtail+PuputのCMSでブログを作る件 備忘録

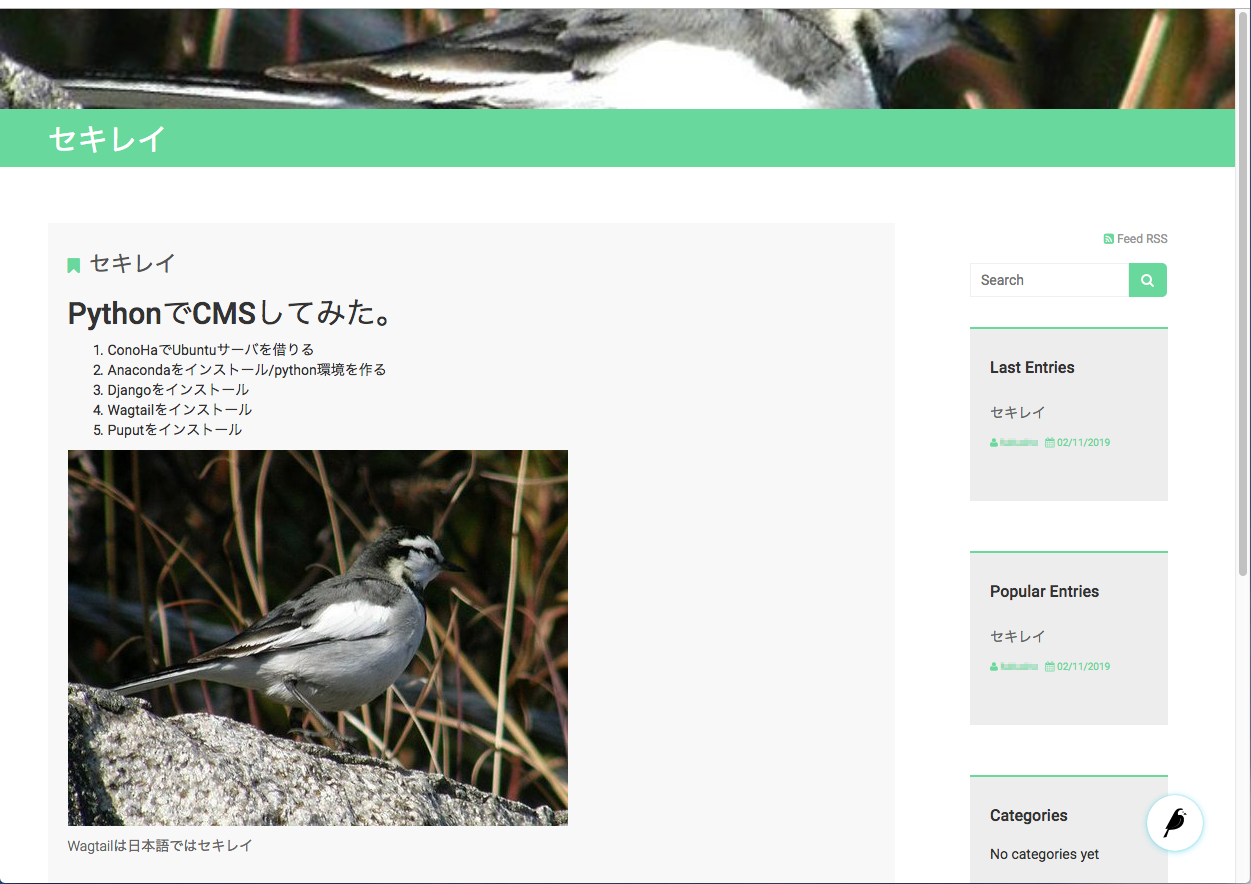

PythonでCMS

最近pythonを使うことが多いのでpythonでCMS環境を構築してみようと思い立ち、やってみました。

紆余曲折の末に次の手順でやるとブログサイトを作り始めるまでに比較的早く辿りつけることがわかってきましたので備忘録としてまとめておきます。

選択としてもっとベターなものがあるかもしれませんが参考まで。サマリー

1.ConoHaでUbuntuサーバを借りる

2.Anacondaをインストール/python環境を作る

3.Djangoをインストール

4.Wagtailをインストール

5.Puputをインストール

6.Wagtailでサイトを作成

7.テストサーバの起動

8.ブラウザからアクセス1.ConoHaでUbuntuサーバを借りる

- 今回はConoHaのUbuntuイメージを選択しました。

- ConohaのVPS Ubuntu 64 / 512 を使う

- クリーンな状態のlinuxサーバを手早く手に入れることが今回の目的です。

調べたところでは。。。

- ConohaのDjangoアプリケーションイメージを最初は使おうとしていたが、入っているpythonも2系で、今後AIをやりたいということもあるのでこのVPSイメージを一旦諦めることにする。

- Linux単体のイメージを使用しpython環境から構築してみることに。

- CentOSよりもUbubntuの方がPython/Djangoに対するフォローが早いようなので Ubuntuにする。

作業用にユーザを一つ作りました。

2.Anacondaをインストール/python環境を作る

ConohaのVPSを使うことにしたのでCUI環境でインストールしなければなりませんが、linuxの場合Anacondaのインストールはシェルスクリプトで行えるのでやってみました。

こちらのサイトを参考にさせていただきました。とてもわかりやすいと思います。

⇨ Ubuntu で Anaconda のインストールAnacondaインストール後

- python3.6の環境を作る$ conda create --name py36 python=3.6.2 $ conda activate py363.Djangoをインストール

$ conda install djangoDjangoはインストールだけしてここでは素通りです。

4.Wagtailをインストール

⇨ "Welcome to Wagtail’s documentation"

$ pip install wagtailここまでで、CMS開発環境ができました。

WagtailがDjango上で使える状態になっているはずですが、先にWagtailで扱えるblogライブラリであるPuputをインストールしてしまいます。5.Puputをインストール

pip install --upgrade pip pip install wheel pip install wagtail django-colorful django-el-pagination django-social-share pip install --no-deps puput6.Wagtailでサイトを作成/Puputの有効化

$ mkdir myProjects $ cd myProjects $ wagtail start mysite $ cd mysite $ pip install -r requirements.txtdjango-adminを使っていませんが、

wagtail start mysiteだけで

django-admin startproject mysiteとpython manage.py startapp homeが行われているように思えます。mysite/settings/base.pyのINSTALLED_APPSに以下を追加

'wagtail.contrib.sitemaps', 'wagtail.contrib.routable_page', 'django_social_share', 'puput', 'colorful',同じく mysite/settings/base.py のどこかに以下を記述

PUPUT_AS_PLUGIN = Trueurls.pyに以下を追加

from puput import urls as puput_urls ...snip url(r'',include(puput_urls)), #この1行を追加 url(r'', include(wagtail_urls)), #この記述が元からあるのでその上にmigrate

$ python manage.py migrate $ python manage.py createsuperuser

python manage.py createsuperuserでCMSの管理者のユーザを設定します。

ブラウザからアクセスした時にこのユーザ名でログインすることでサイトやブログの管理を行います。7.テストサーバの起動

Djangoがローカルのマシンで動いているわけではないので、リモートでアクセス可能なように起動時にオプションをつけます。

$ python manage.py runserver xxx.xxx.xxx.xxx:ppppxxx.xxx.xxx.xxx:pppp は今まさに使っているConoHaのVPSのアドレスと任意のポート番号です。

Djangoを直接使用する場合にはsettings.pyにALLOWED_HOSTS = ['xxx.xxx.xxx.xxx']を記述しておく必要がありますが、wagtailでは必要ありませんでした。

開発用なので本運用には不適当です。8.ブラウザからアクセス

ログイン

上で、123.456.789.123:8080でサーバを起動したとしたら、

http://123.456.789.123:8080/admin/ で作成したサイトの管理画面に入れます。

ログインを促されるので、設定したユーザ名/パスワードでログインします。サイトの設定

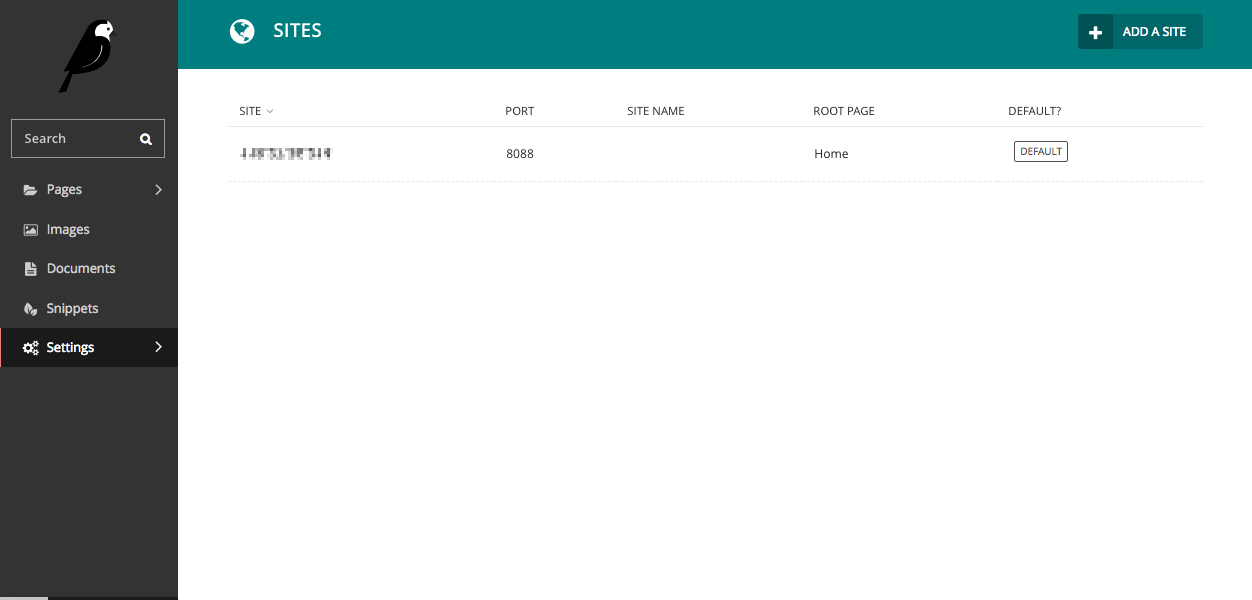

Defaultの状態では、サイトのアドレスがlocalhostの8000になっているので開発環境に合わせておきます。

左のパネルから Settings > Sites を選択しSITEとport番号をサーバを起動した時のxxx.xxx.xxx.xxx:ppppに合わせます。

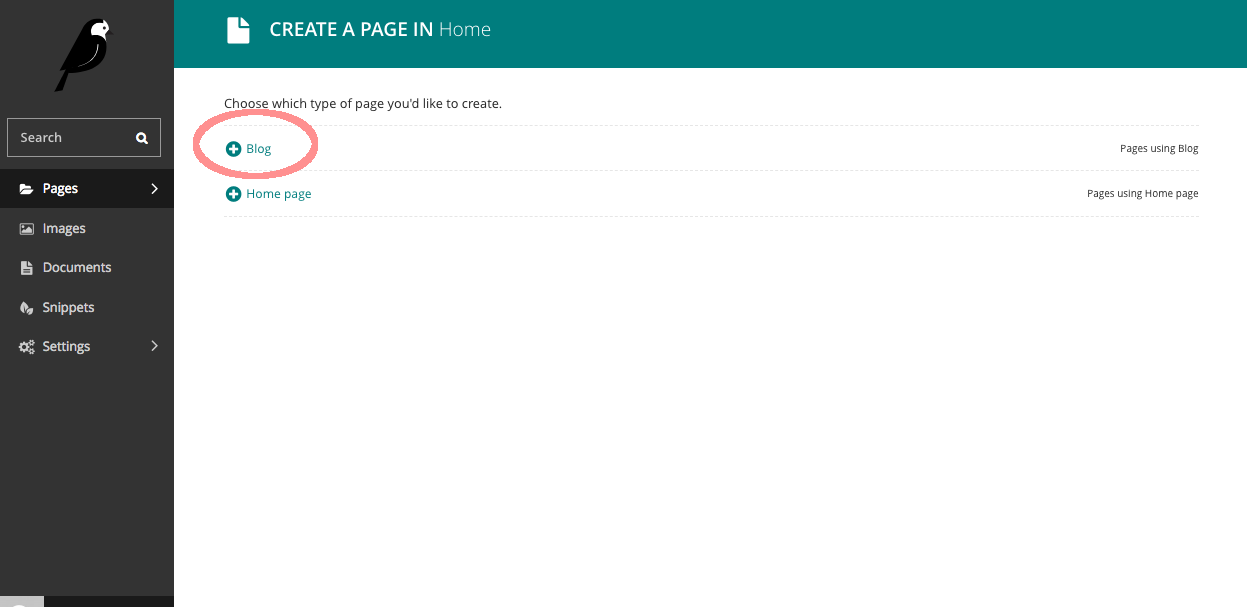

Blogページの作成

本来Wagtailを導入しただけだと、CMSの環境にはなりますが空っぽの状態なので、実装して作り込んで行かなくてはなりません。

実装にはDjangoやWagtailの知識が必要になりますが、今回はPuputを入れて有効にしているので、最初からブログのページを作成することができました。

以上備忘録でした。

ちなみにDjangoには詳しくないので。。。これを機会に勉強してみます。

参考にさせてもらったサイト/記事

PythonでCMS、どれ使えばいいの? 〜Mezzanine vs django CMS vs Wagtail〜

Djangoを最速でマスターする part1

Ubuntu で Anaconda のインストール

wagtail Your first Wagtail site を参考に、Blog を作る

- 投稿日:2019-02-11T22:48:53+09:00

if __name__ == '__main__' とはなにか

コードの例などでよく見る

if __name__ == '__main__'について、ずっとモヤらせていたものを調べたので記録。if name == 'main' とはなにか

簡単に言えば、「外部からimportして読み込んだときに実行されないようにするため」のもの。

pythonは同じディレクトリであれば

import ファイル名でモジュールとして読み込みができる。この読み込みのときにはコード全体が実行されるため、平文で書いていたらimportしたときに値が返ってきてしまう。たとえば、

python:hello.py

print('hello world')

上のコードを別のファイルからimport helloとすると読み込めるが、読み込みと同時にhello worldと返ってきてしまう。これはいけてない。し、場合によっては不具合がでうる。それを防ぐためには、

python:hello.py

if __name__ == '__main__':

print('hello world')

とするだけでOK。なぜか

どうやらimportする際には内部で

__name__という変数にモジュール名が与えられているらしい。hello.pyをモジュールとして実行すると

__name__はhelloになる。

なのでif文は実行されなかったという仕組みっぽい。

- 投稿日:2019-02-11T22:34:22+09:00

Macで使うmatplotlibのbackendエラー

はじめに

pythonを使ったデータ解析環境として、まず用意したいライブラリの一つが、matplotlibだと思います。少なくとも僕はそう思っています。

なので、macのpython環境でもまずmatplotlibを入れることを考えました。matplotlibのインストールと実行

とりあえずpipenv環境をactivateして、いつも通り下記を実行すると問題なくするっと入ります。

$ pip install matplotlibじゃあいけるだろうと思い、下記を実行。

main.pyimport matplotlib.pyplot as plt a = [1, 2, 5, 4, 3] plt.plot(a)ImportError: Python is not installed as a framework. The Mac OS X backend will not be able to function correctly if Python is not installed as a framework. See the Python documentation for more information on installing Python as a framework on Mac OS X. Please either reinstall Python as a framework, or try one of the other backends. If you are using (Ana)Conda please install python.app and replace the use of 'python' with 'pythonw'. See 'Working with Matplotlib on OSX' in the Matplotlib FAQ for more information.なんかエラー出た。。

macでのmatplotlibインストール エラー対策

どうやらmacあるあるらしく、たくさん解決法が書いてありました。

matplotlibのmatplotlibrcファイルのbackendをmacosxから、TkAggに変えろ、というもの。

早速、matplotlibrcの場所を下記コマンドで調べて書き換える。import matplotlib matplotlib.matplotlib_fname() .venv/lib/python3.5/site-packages/matplotlib/mpl-data/matplotlibrc'matplotlibrc# backend: macosx backend: TkAggそして、また実行してみると、

いやいや、グラフ出ないじゃん。ということで、別情報を得て、backendをQtAggに変更するとできると知る。GUIとしてPyQtを使う手のようです。下記の方法でうまくいきました。

$ pip install PyQt5matplotlibrc# backend: macosx # backend: TkAgg backend: Qt5Aggこれで、matplotlibのコードを動かすと・・

動きました。まとめ

とりあえず2019/2の段階では、PyQt5をインストールして、backendをQt5Aggにすれば動きそうです。Qt4Aggにすれば動くという話も出回っていますが、私の環境ではうまくいきませんでした。

皆さんのご参考になれば。

- 投稿日:2019-02-11T22:03:36+09:00

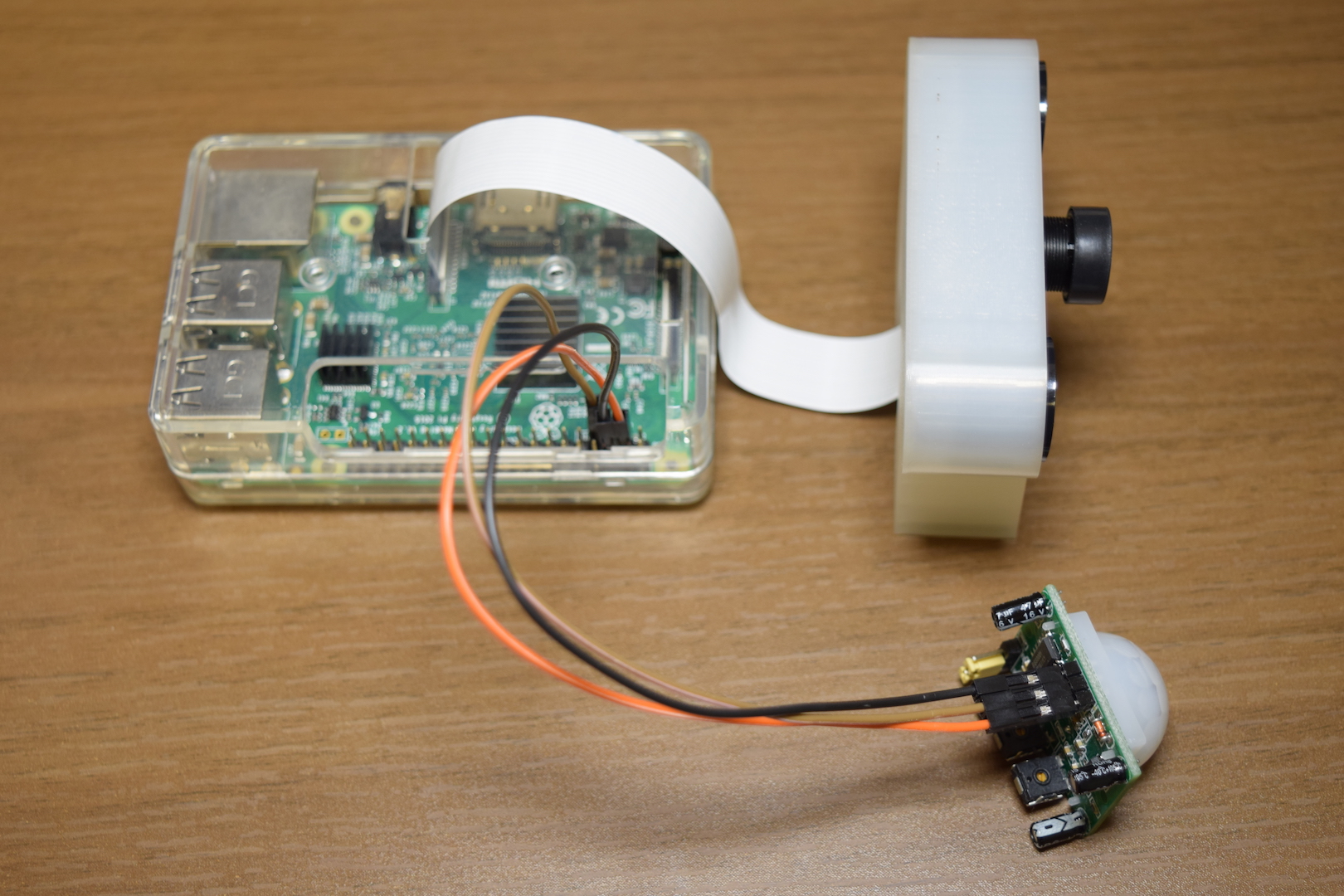

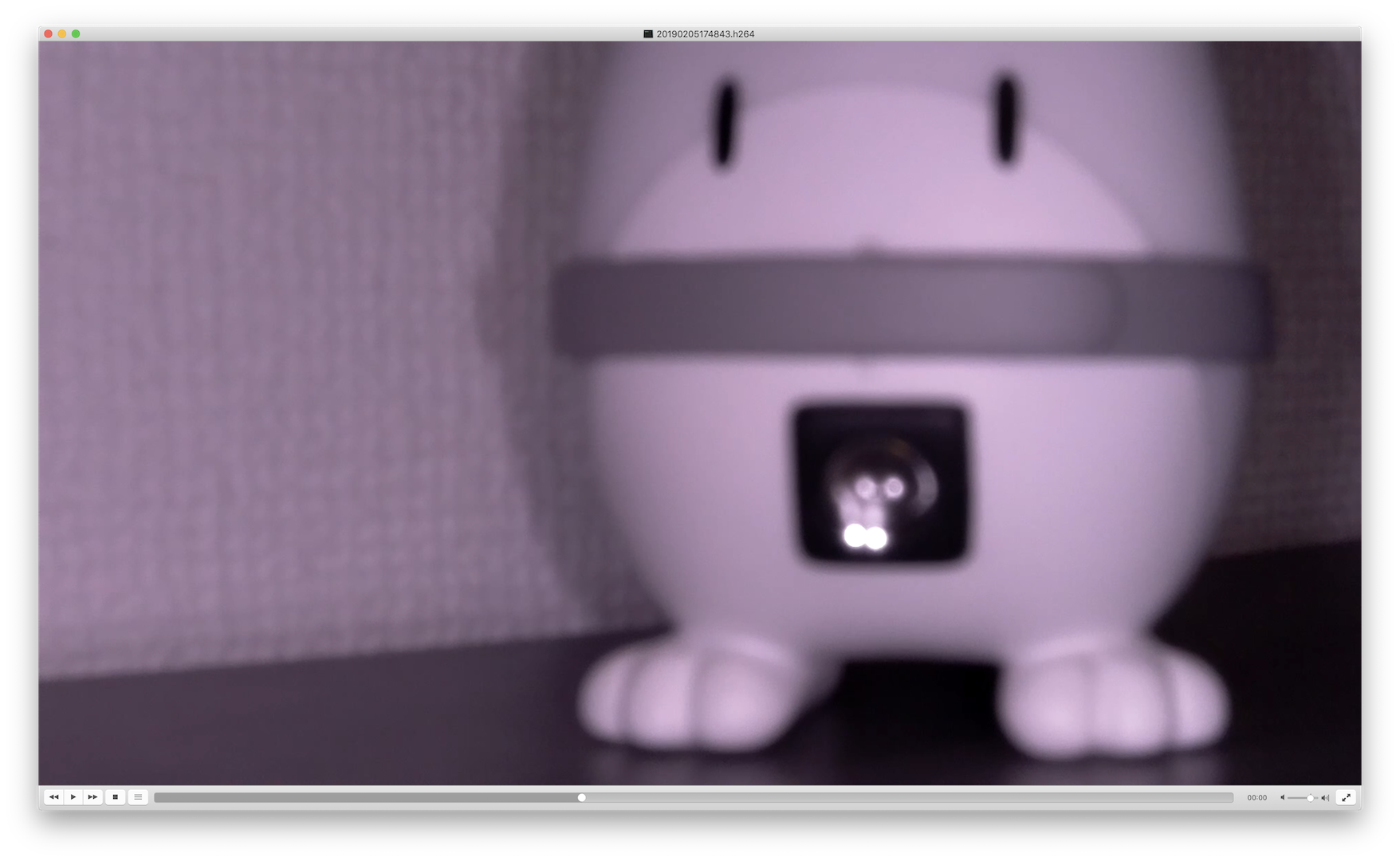

Raspberry Pi(Raspbian)でモーションセンサー式の防犯カメラ的なものを作ってみる

はじめに

Raspberry Pi(Raspbian)でモーションセンサー式の防犯カメラ的なものを作る方法です。

必要なもの

- RaspbianがインストールされているRaspberry Pi

- Raspberry Pi用のカメラモジュール

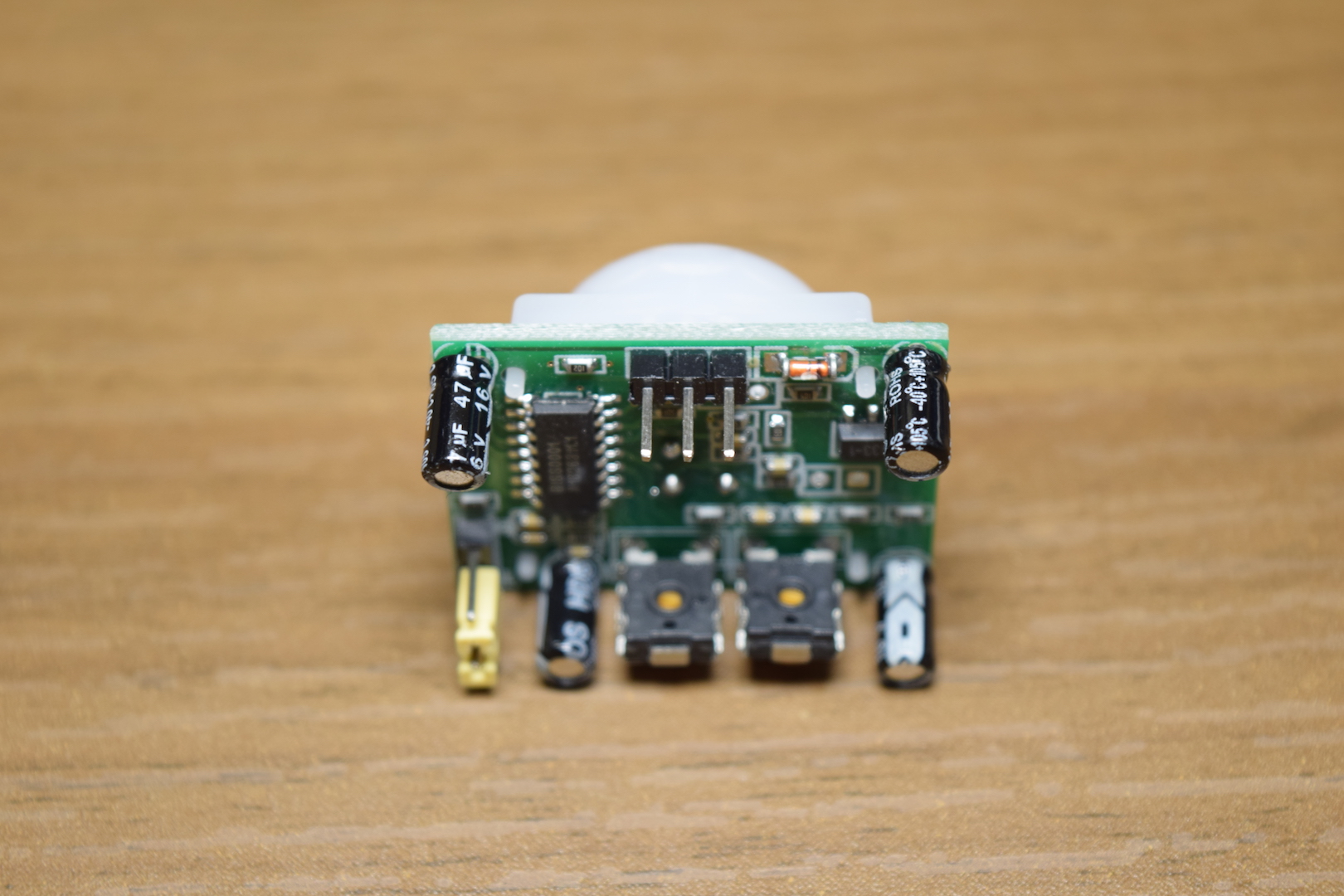

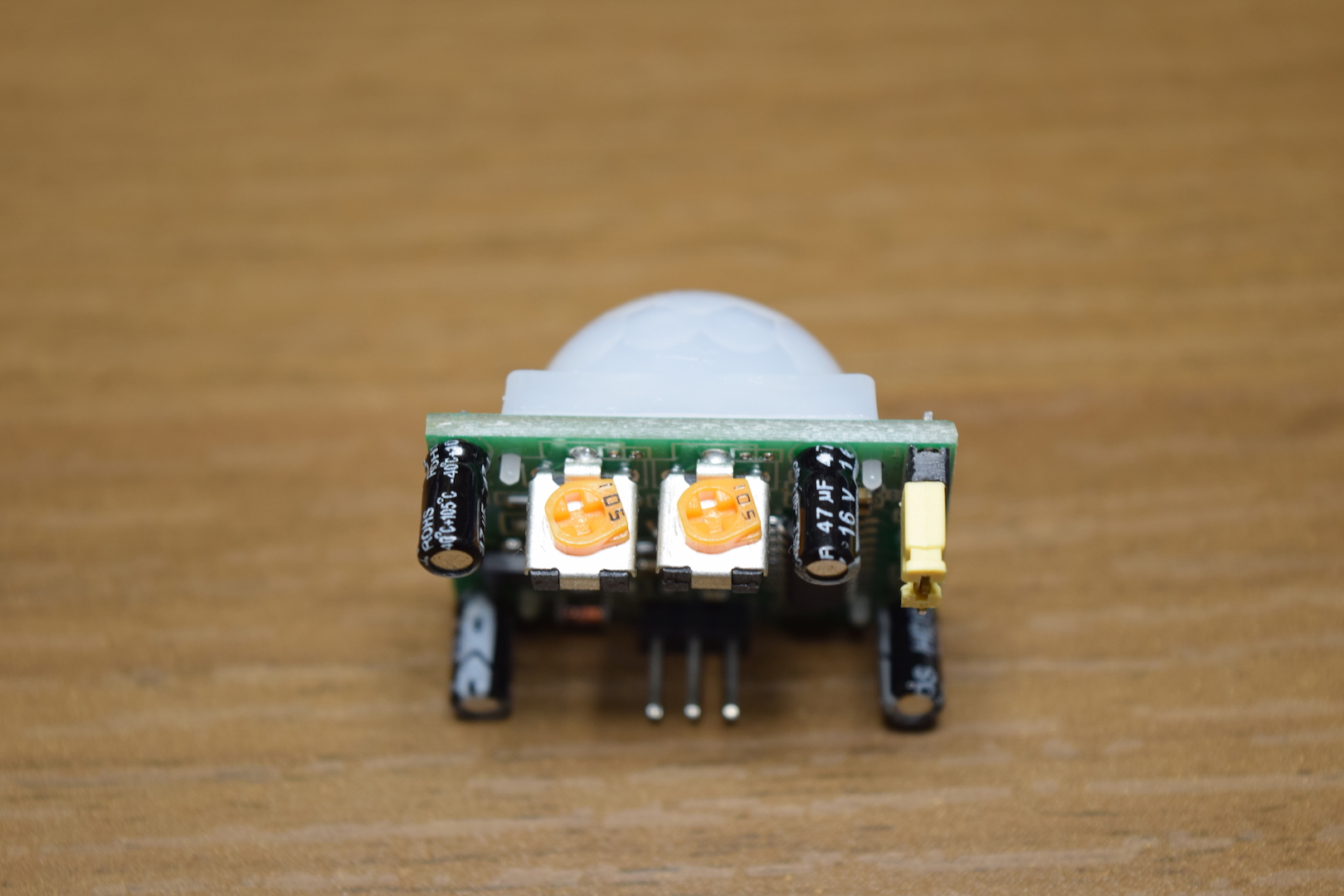

- 赤外線モーションセンサー(HC-SR501)

- ジャンパー線(メス/メス)x3

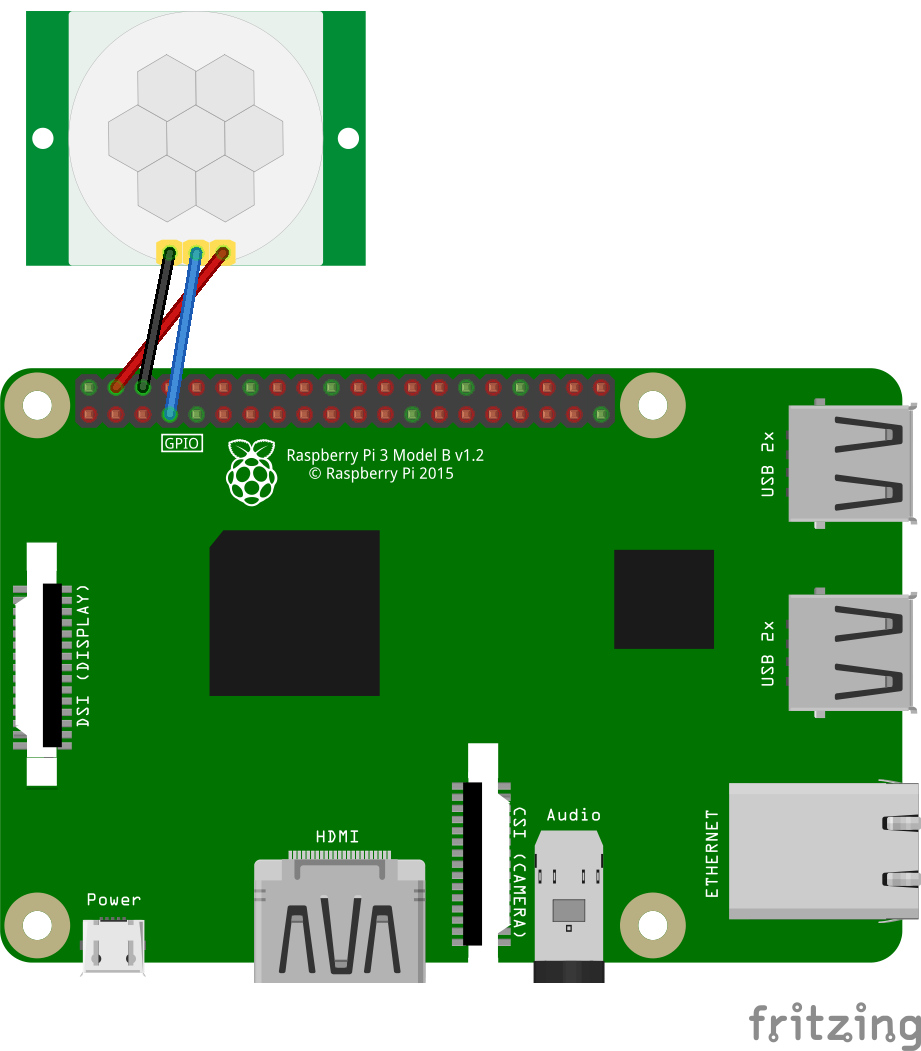

配線

GPIO, 5V, GNDならどこでも可ですが、今後の拡張性などを考えるとGPIOのみのピン(3, 5, 8, 10, 19, 21, 23, 24, 25以外)を使う方が無難だと思います。

この投稿では4(5V), 6(GND), 7(GPIO4)ピンを使用しています。

↓HC-SR501の配線は左から順にGND, OUT, VCC。

↓右側のダイヤルで距離、左側のダイヤルで時間を調整することができるので、使用用途と環境に合わせて調整する。(調整するのが面倒なら↓と同じにしておけばOK)

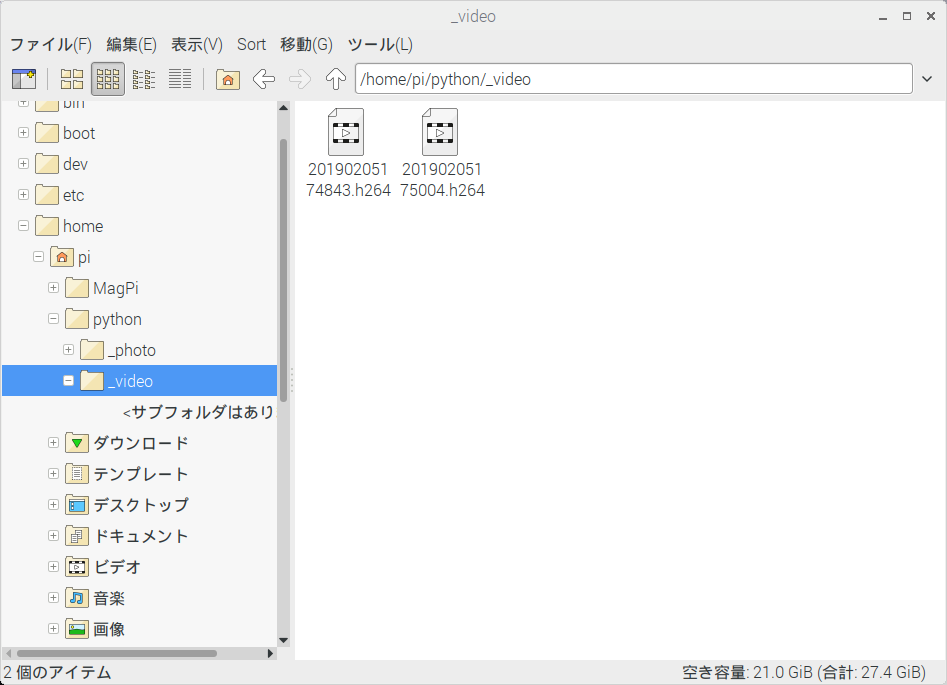

プログラム

security_camera.py#Import Files import RPi.GPIO as GPIO import picamera import time #GPIO Settings GPIO.setmode(GPIO.BCM) GPIO.setup(4, GPIO.IN, pull_up_down=GPIO.PUD_DOWN) #Camera Settings CAM_DIR = "/home/pi/python/_video/" camera = picamera.PiCamera() #Main try: while True: if GPIO.input(4) == 1: filename = time.strftime("%Y%m%d%H%M%S") + ".h264" save_dir_filename = CAM_DIR + filename camera.start_recording(save_dir_filename) camera.wait_recording(300) camera.stop_recording() else: pass except KeyboardInterrupt: GPIO.cleanup()解説

- スイッチの制御に使用する

RPi.GPIOライブラリをインポートする- Raspberry Piのカメラモジュールの制御に使用する

picameraライブラリをインポートする- 時間を取得するために使用する

timeライブラリをインポートする- GPIOのモードをBCMに設定する(物理的なピン番号ではなく、GPIO**を使用する)

- GPIO4を入力端子に設定し、状態をプルダウン(Low)にする(Hi=ON, Low=OFF)

CAM_DIRに保存先のディレクトリを設定する- PiCameraクラスのインスタンスを生成する

while True:で解説9〜16の処理を無限ループさせる- センサーが動きを検知したら(GPIO4がHiになったら)動画を撮る処理を行う

time.strftimeでセンサーが動きを検知した時の日時を取得するtime.strftimeで取得した日時+拡張子(.h264)をファイル名にするCAM_DIRで指定したディレクトリとファイル名を連結させるcamera.start_recordingで動画を撮るcamera.wait_recordingで指定した時間が経過したら動画を撮る処理を終了する(括弧には秒数を入れる)CAM_DIRで指定したディレクトリに動画を保存する- 解説9に遷移 or プログラムが終了するのを待つ

- Control+Cが押されたらGPIOを解放してプログラムを終了する

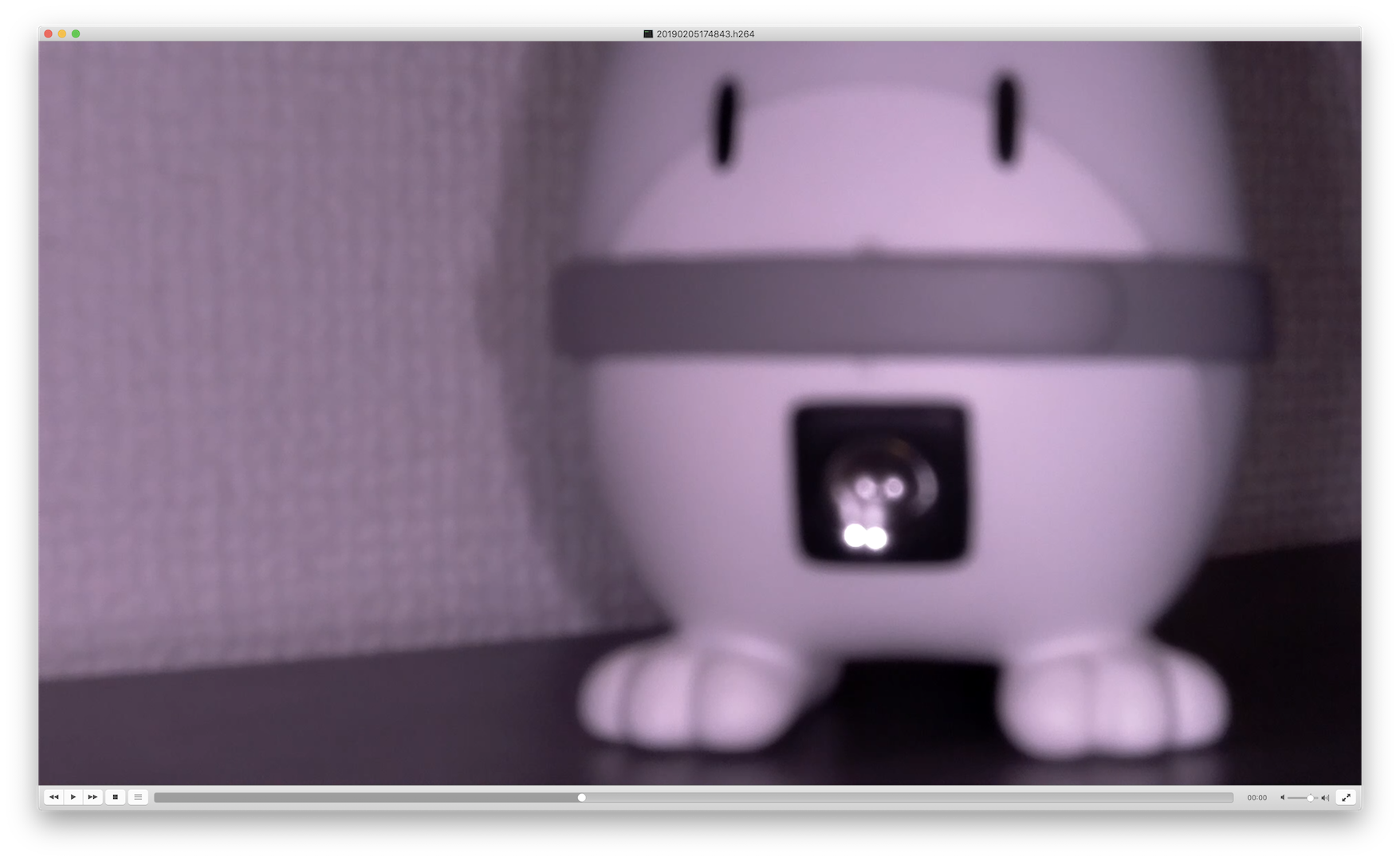

プログラムを実行してみる

- プログラムを実行する

- センサーが動きを検知すると動画ファイルに記録される

- 人や動物など、動くものが映っていれば完成(Raspberry Piだと正常に再生できないので手持ちのPCにコピーして再生する)

参考

- 「Raspberry Pi(Raspbian)で写真を撮るプログラムを作る」と組み合わせることで

センサーが動きを検知したら写真を撮るプログラムを作ることができる- センサーの状態(Hi/Low)は目視で確認できないので、GPIOの入力値を

- 動画の保存先には使い捨ての外部ストレージ(USBメモリ)などを指定した方が安全に運用できる

- 屋外に設置すると雨などの影響で壊れる可能性が高いので、屋内での運用が望ましい

- 投稿日:2019-02-11T22:03:02+09:00

カメの甲羅をobject detection apiで認識してみる on win10

えー、リクガメ関連のエントリで染まって来ておりますが、更に浸かっていきます。

これまでの経緯としては・・

AppSyncとDynamodbとkinesisVideoStreamとリクガメモニタリング

が最後の方ですかね。くす玉システムもあるけど。

で、Nextとしては

・カメの位置を画像から捕捉し、カメラを向ける

・カメの移動距離を測る

・hlsのm3u8にWeb Video Text Track (WebVTT)を混ぜ込むとか妄想しています。

カメの位置の捕捉についてはなんとなくイメージできてるけどとりあえずやってみておきましょうか、というそういうエントリになります。

実際の動作環境はLinux上になると思うのですがまずはwindowsでお試し。環境

- win10 64bit

- python 3.6.6

- pip 18.1

- tensorflow 11.1

だったけどpipとtennsorflowはupgradeしときます

python -m pip install --upgrade pip pip install --upgrade https://storage.googleapis.com/tensorflow/windows/cpu/tensorflow-1.12.0-cp36-cp36m-win_amd64.whl

- pip 19.0.2

- tensorflow 1.12.0

になりました。

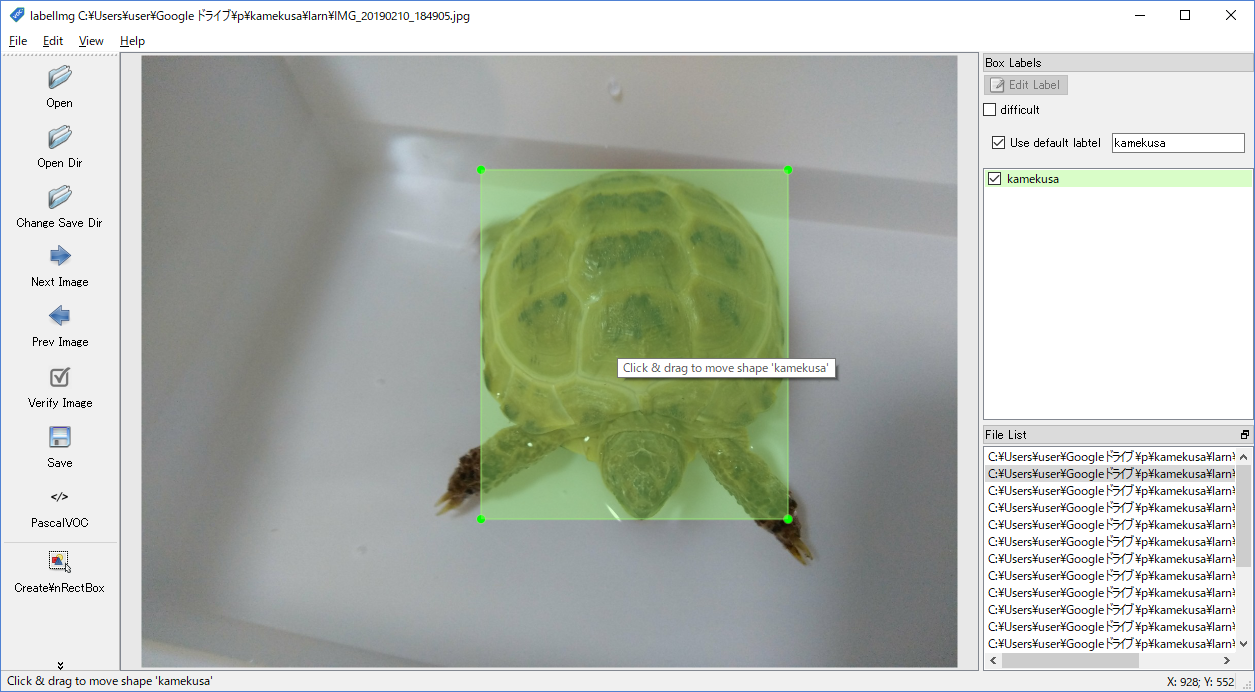

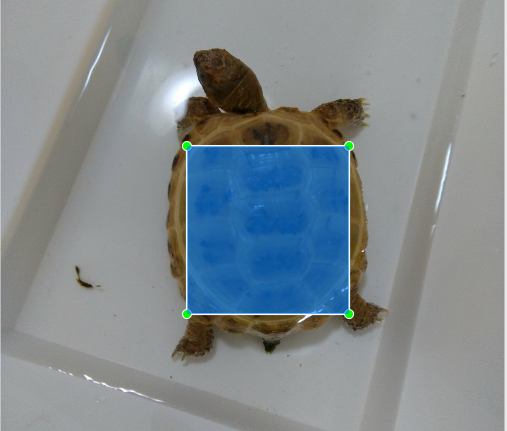

ラベリング

今回はカメの甲羅を学習させて覚えさせたいと思います。

床材と色が似てるし、識別どうなのかなー、とか思ったけど甲羅って特徴的だし案外イケるんでは?と思ってたりしております。

なお、TensorflowのObject Detection APIを使うのですが、いつものようにQiitaにお世話になります。Tensorflow Object Detection APIで寿司検出モデルを学習するまで

windowsにも対応しているlabelImgというツールをセットアップします。

windows_v1.8.1.zipというファイルをDL -> 解凍 -> labelImg.exeを実行操作は直感的。ディレクトリを開いて、画像の上で右クリックして

Create\nRectBox、甲羅を囲んでkamekusaとラベリングしました。

これを20枚分。いろんな角度から撮ってるけどだいたい同じ画像です。画像一枚毎にxmlファイルが出来上がりました。1枚にまとまってくれると楽なんだけど、そういう風にできないもんかな。(出来そうな気はするけど今はいいや。)

TFRecordの作成

次はTFRecordというTensorflowに対応した形に画像とラベリングデータを変換する必要があります。

との事です。このままでは使えないのか。

こちらを使わせていただきます。git clone https://github.com/Jwata/sushi_detector_dataset.gitdata/sushi_label_map.pbtxt はkame_label_map.pbtxtに変えます。

imagesとannotationsというディレクトリを作り、画像は前者、xmlは後者に。

ちなみに画像はjpgで、拡張子以外は画像もxmlファイルも共通です。pip intall lxml pip install object_detection python create_tf_record.py --annotations_dir=.\annotations --images_dir=.\images --output_dir=.\data\ --label_map_path=.\data\kame_label_map.pbtxtなんか一回、これにひっかかる

Traceback (most recent call last): File "create_tf_record.py", line 14, in <module> from object_detection.utils import dataset_util, label_map_util File "C:\Users\user\AppData\Local\Programs\Python\Python36\lib\site-packages\object_detection\utils\label_map_util.py", line 21, in <module> from object_detection.protos import string_int_label_map_pb2 ImportError: cannot import name 'string_int_label_map_pb2'tensorflow/modelsというのがいるらしい。準備不足でした。

git clone https://github.com/tensorflow/models.gitまずはこちらを参考に。

cloneしてきたデータをsushi_detector_datasetのディレクトリ内にmodelsという名前でおきます。

お次はprotocというのを実行するらしい。

ここにありました。 https://github.com/protocolbuffers/protobuf/releases

最初3.7をDLしたのですが、うまくいかなかったので手順と同じ3.4にしたらうまくいきました。(どうやら3.5以上ではfor /r %v in (object_detection/protos/*.proto) do protoc "object_detection/protos/%~nxv" –python_out=.ってやると成功するもよう)cd models\research .\protoc.exe object_detection\protos\*.proto --python_out=.で、できたやつを

C:\Users\user\AppData\Local\Programs\Python\Python36\lib\site-packages\object_detection\protosにコピってみた。

models/research/object_detectionで作業すればpathは問題ないのかも。もしくは環境変数のPYTHONPATHあたりを設定するか。

とりあえず自分の環境で動かせるようにした感じです。(※結論からいうと落としてきたレポジトリのmodels/research/object_detectionを作業ディレクトリにしちゃえばよかったです)なんかtrainval.txtにファイルを羅列しなくちゃいけないっぽく、gitのbash(windowsのgit入れる時に入るやつ)でやりました。単にテキストファイルに学習したいファイルの拡張子抜きのファイル名が羅列されてればいいみたい。

$ cd [projectdir]/annotations $ for f in *.xml ; do echo ${f:0:-4} >> trainval.txt; donetrainval.txtIMG_0001 IMG_0002みたいなファイルがあって、imagesにはIMG_0001.jpgやIMG_0002.jpgが、annotationsにはIMG_0001.xmlやIMG_0002.xmlが入ってる感じです。

で、cmdにてpython create_tf_record.py --annotations_dir=.\annotations\ --images_dir=.\images\ --output_dir=.\data\ --label_map_path=.\data\kame_label_map.pbtxtkame_train.recordとか、dataディレクトリの中身が更新されてたし、これでええんやろか。

トレーニングConfigファイルの作成

なんだろうか、これ。

学習させるときのパラメーターとかが書かれてるっぽいけど、

とりあえず、git cloneしてきたファイルにssd_mobilenet_v1_sushi.docker.configというのがあるので複製してみる。ssd_mobilenet_v1_kame.configとした。

なお、pathがすべてスラッシュ(/)区切りで書かれてたけどwindows風のセパレータに変えております。

学習に使うファイルとかのpathや、反復回数とかを設定できるっぽいです。トレーニング

そして学習済モデルのDLが必要らしい。今回はカメだけ認識できればいいから細かいことはなんか適当に。

coco(common objects in context)ってモデルをひとまずベースにするのがいいらしいです。mobilenetのv1ってのか1番ライトなやつっぽい。rnnってついてるのが遅いけど正確。curl -O http://download.tensorflow.org/models/object_detection/ssd_mobilenet_v1_coco_2018_01_28.tar.gz tar zxvf ssd_mobilenet_v1_coco_2018_01_28.tar.gz(何でDLしてもいいです。tar.gzはwindowsではなじみがないですが7-Zipとかで解凍できるみたいです)

落としたものは解凍して、data/ssdとして保存しました。そして、ひとまず

Python -m object_detection.trainしてみるんだけど、train.pyなんてものがない。はて。https://stackoverflow.com/questions/51404957/tensorflow-object-detection-api-no-train-py-file

ほー。なんかlegacyってとこに移動したって。

あとDLしたmodelのslimってのがPYTHONPATHにないといけないみたいなので設定する。

そして実行。set PYTHONPATH=%PYTHONPATH%;c:\a\kame\sushi_detector_dataset\models\research\slim python -m object_detection.legacy.train --logtostderr --pipeline_config_path=.\data\ssd_mobilenet_v1_kame.config --train_dir=.\data\trainで、実行してみたら負荷かかりすぎてPCがフリーズした。。configいじった方が良さそうだ。

TensorFlow Object Detectionチュートリアルのデータセットを変えて学習させたい

こちらがすごくわかりやすい。

わけもわからないままやってた事がこれ見てわかってきた。

ふむ。configはmodel.num_classesとtrain_config.batch_sizeは変えないといけなそう。batch_sizeは2くらいにしとこう。

あとnum_stepsとnum_examplesを減らす。

いいや、せっかくDLしたけど使用済モデルも無しにしてみよう。

fine_tune_checkpointをコメントアウトし、from_detection_checkpointはfalseに。

PCはGPUはおろか、core i5のしょぼいノートPCですので。

実は一回、num_stepsを20000で始めてしまって、ぜんぜん終わらないのでCtrl+Cした経緯があります。結果、configはこんな感じになりました。

ssd_mobilenet_v1_kame.configmodel { ssd { num_classes: 1 box_coder { faster_rcnn_box_coder { y_scale: 10.0 x_scale: 10.0 height_scale: 5.0 width_scale: 5.0 } } matcher { argmax_matcher { matched_threshold: 0.5 unmatched_threshold: 0.5 ignore_thresholds: false negatives_lower_than_unmatched: true force_match_for_each_row: true } } similarity_calculator { iou_similarity { } } anchor_generator { ssd_anchor_generator { num_layers: 6 min_scale: 0.2 max_scale: 0.95 aspect_ratios: 1.0 aspect_ratios: 2.0 aspect_ratios: 0.5 aspect_ratios: 3.0 aspect_ratios: 0.3333 } } image_resizer { fixed_shape_resizer { height: 300 width: 300 } } box_predictor { convolutional_box_predictor { min_depth: 0 max_depth: 0 num_layers_before_predictor: 0 use_dropout: false dropout_keep_probability: 0.8 kernel_size: 1 box_code_size: 4 apply_sigmoid_to_scores: false conv_hyperparams { activation: RELU_6, regularizer { l2_regularizer { weight: 0.00004 } } initializer { truncated_normal_initializer { stddev: 0.03 mean: 0.0 } } batch_norm { train: true, scale: true, center: true, decay: 0.9997, epsilon: 0.001, } } } } feature_extractor { type: 'ssd_mobilenet_v1' min_depth: 16 depth_multiplier: 1.0 conv_hyperparams { activation: RELU_6, regularizer { l2_regularizer { weight: 0.00004 } } initializer { truncated_normal_initializer { stddev: 0.03 mean: 0.0 } } batch_norm { train: true, scale: true, center: true, decay: 0.9997, epsilon: 0.001, } } } loss { classification_loss { weighted_sigmoid { anchorwise_output: true } } localization_loss { weighted_smooth_l1 { anchorwise_output: true } } hard_example_miner { num_hard_examples: 3000 iou_threshold: 0.99 loss_type: CLASSIFICATION max_negatives_per_positive: 3 min_negatives_per_image: 0 } classification_weight: 1.0 localization_weight: 1.0 } normalize_loss_by_num_matches: true post_processing { batch_non_max_suppression { score_threshold: 1e-8 iou_threshold: 0.6 max_detections_per_class: 100 max_total_detections: 100 } score_converter: SIGMOID } } } train_config: { batch_size: 2 optimizer { rms_prop_optimizer: { learning_rate: { exponential_decay_learning_rate { initial_learning_rate: 0.004 decay_steps: 800720 decay_factor: 0.95 } } momentum_optimizer_value: 0.9 decay: 0.9 epsilon: 1.0 } } #fine_tune_checkpoint: ".\data\ssd\model.ckpt" from_detection_checkpoint: false # Note: The below line limits the training process to 200K steps, which we # empirically found to be sufficient enough to train the pets dataset. This # effectively bypasses the learning rate schedule (the learning rate will # never decay). Remove the below line to train indefinitely. #num_steps: 200000 num_steps: 100 data_augmentation_options { random_horizontal_flip { } } data_augmentation_options { ssd_random_crop { } } } train_input_reader: { tf_record_input_reader { input_path: ".\data\kame_train.record" } label_map_path: ".\data\kame_label_map.pbtxt" } eval_config: { num_examples: 20 # Note: The below line limits the evaluation process to 10 evaluations. # Remove the below line to evaluate indefinitely. max_evals: 10 } eval_input_reader: { tf_record_input_reader { input_path: ".\data\kame_val.record" } label_map_path: ".\data\kame_label_map.pbtxt" shuffle: false num_readers: 1 num_epochs: 1 }num_stepsを100にしたせいか、15分くらいで終わりました。

精度がどの程度出てるかはわからないけど、ひとまず先に進みましょう。Jupyter notebook

出来上がったモデルを試してみます。

手っ取り早く、Jupyter notebookで。

とかいいつつ使うのはじめてだし、setupからですけど。

(ただ、Kaggleでそれっぽいのは使ったことある)

で、DLしてきたmodelsの中にnotebookのソースがあったのでそれを動かしてみる。

というかmodels\research\object_detectionをプロジェクトディレクトリとしちゃった方が良さそうな気がしてきました。

出来上がったdataフォルダをコピーします。

あとtest_imagesに、テストしたい画像を置きました。cd models\research\object_detection pip install Jupyter pip install Matplotlib Jupyter notebookmatplotlibも使いそうなのでinstallしました。

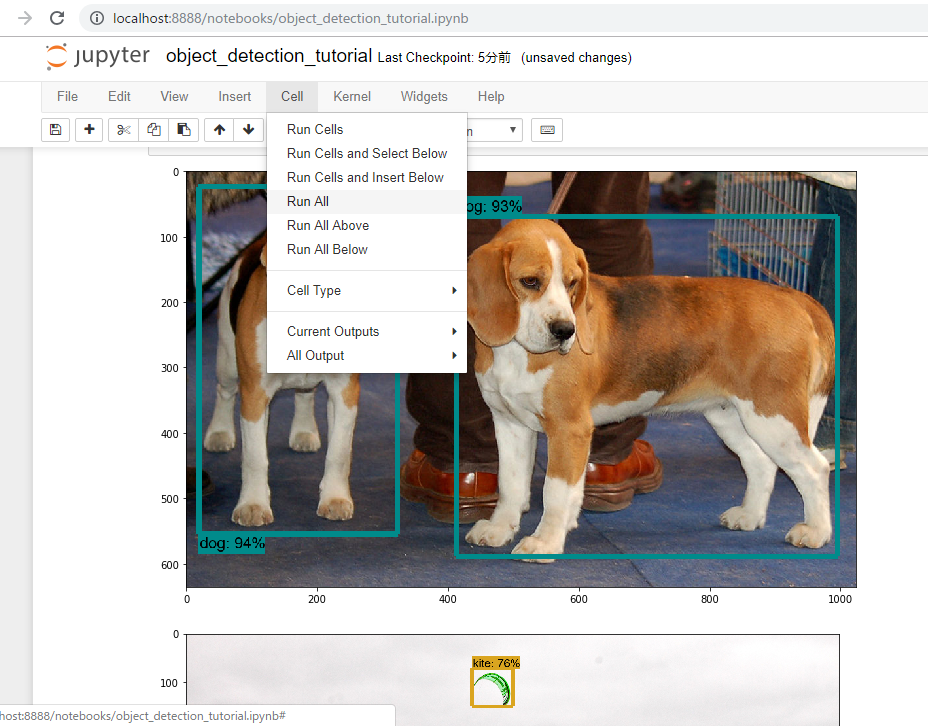

で、一回runAllしてみます。dogだとかkiteだとかpersonだとか、ちゃんと認識してます。

次は自作の方を・・

Any model exported using the export_inference_graph.py tool can be loaded here simply by changing PATH_TO_FROZEN_GRAPH to point to a new .pb file.とあるのでexport_inference_graph.pyを実行しますpython export_inference_graph.py --input_type image_tensor --pipeline_config_path .\data\ssd_mobilenet_v1_kame.config --trained_checkpoint_prefix .\data\train\model.ckpt-100 --output_directory inference_graphそしたらinference_graph/frozen_inference_graph.pbというのができたのでnotebookを書き換えます。

# What model to download. #MODEL_NAME = 'ssd_mobilenet_v1_coco_2017_11_17' #MODEL_FILE = MODEL_NAME + '.tar.gz' #DOWNLOAD_BASE = 'http://download.tensorflow.org/models/object_detection/' # Path to frozen detection graph. This is the actual model that is used for the object detection. PATH_TO_FROZEN_GRAPH = 'inference_graph/frozen_inference_graph.pb' # List of the strings that is used to add correct label for each box. PATH_TO_LABELS = os.path.join('data', 'kame_label_map.pbtxt')Download Modelのとこは全てコメント化

#opener = urllib.request.URLopener() #opener.retrieve(DOWNLOAD_BASE + MODEL_FILE, MODEL_FILE) #tar_file = tarfile.open(MODEL_FILE) #for file in tar_file.getmembers(): # file_name = os.path.basename(file.name) # if 'frozen_inference_graph.pb' in file_name: # tar_file.extract(file, os.getcwd())あとは3つめの画像を判別したいので

TEST_IMAGE_PATHS = [ os.path.join(PATH_TO_TEST_IMAGES_DIR, 'image{}.jpg'.format(i)) for i in range(3, 4) ]とするそしたらRun ALLいきます。

ん~・・微妙。。

学習が全然たりないのかなぁ。。

再学習

fine_tune_checkpoint、from_detection_checkpoint、num_stepsを変更します。

ssd_mobilenet_v1_kame.configfine_tune_checkpoint: ".\data\ssd\model.ckpt" from_detection_checkpoint: true num_steps: 2000これで5時間くらいか?

そんなわけでも一度。トレーニングデータの場所はちょっと変える。python -m object_detection.legacy.train --logtostderr --pipeline_config_path=.\data\ssd_mobilenet_v1_kame.config --train_dir=.\data\train.1でもまた失敗。。

labelImgの時の範囲指定が大きすぎたかなあ。

欲張らず甲羅だけ指定するようにしてみる。そしてcreate_tf_record.py をまたやってTFRecord作成し、またトレーニング実行。

2000stepだと4時間くらいかかったし、まずはお試しで200stepから。

あとmatched_thresholdとunmatched_thresholdを0.5から0.7に変えました。python -m object_detection.legacy.train --logtostderr --pipeline_config_path=.\data\ssd_mobilenet_v1_kame.config --train_dir=.\data\train.2 ... INFO:tensorflow:Recording summary at step 191. INFO:tensorflow:Recording summary at step 191. INFO:tensorflow:global step 192: loss = 7.9095 (7.091 sec/step) INFO:tensorflow:global step 192: loss = 7.9095 (7.091 sec/step) INFO:tensorflow:global step 193: loss = 14.9527 (5.446 sec/step) INFO:tensorflow:global step 193: loss = 14.9527 (5.446 sec/step) INFO:tensorflow:global step 194: loss = 7.4112 (7.121 sec/step) INFO:tensorflow:global step 194: loss = 7.4112 (7.121 sec/step) INFO:tensorflow:global step 195: loss = 8.6017 (6.059 sec/step) INFO:tensorflow:global step 195: loss = 8.6017 (6.059 sec/step) INFO:tensorflow:global step 196: loss = 7.5035 (6.000 sec/step) INFO:tensorflow:global step 196: loss = 7.5035 (6.000 sec/step) INFO:tensorflow:global step 197: loss = 7.5494 (10.491 sec/step) INFO:tensorflow:global step 197: loss = 7.5494 (10.491 sec/step) INFO:tensorflow:global step 198: loss = 6.6824 (5.668 sec/step) INFO:tensorflow:global step 198: loss = 6.6824 (5.668 sec/step) INFO:tensorflow:global step 199: loss = 7.5866 (6.179 sec/step) INFO:tensorflow:global step 199: loss = 7.5866 (6.179 sec/step) INFO:tensorflow:global step 200: loss = 23.8177 (5.964 sec/step) INFO:tensorflow:global step 200: loss = 23.8177 (5.964 sec/step) INFO:tensorflow:Stopping Training. INFO:tensorflow:Stopping Training. INFO:tensorflow:Finished training! Saving model to disk. INFO:tensorflow:Finished training! Saving model to disk.んー。lossの値が大きい。2000回やった時は3ぐらいまで下がってたけど。

とりあえずJupyter notebook起動してみる。

・・が、何も認識できていない結果となりました。。

matched_threshold変えたから閾値にひっかかってるのかな。

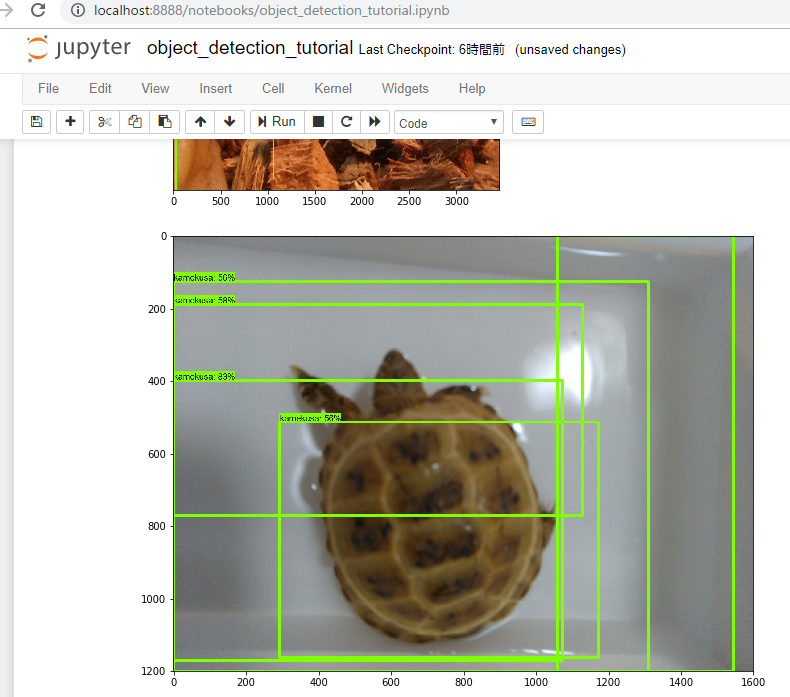

ただ、checkpointがあるので続きからできるはず。num_stepsを800にしてもう少しトレーニングを進めます。そしてJupyter notebookを再度起動。

そして・・

またアカン。。なんかよくわからんところが認識されてる。

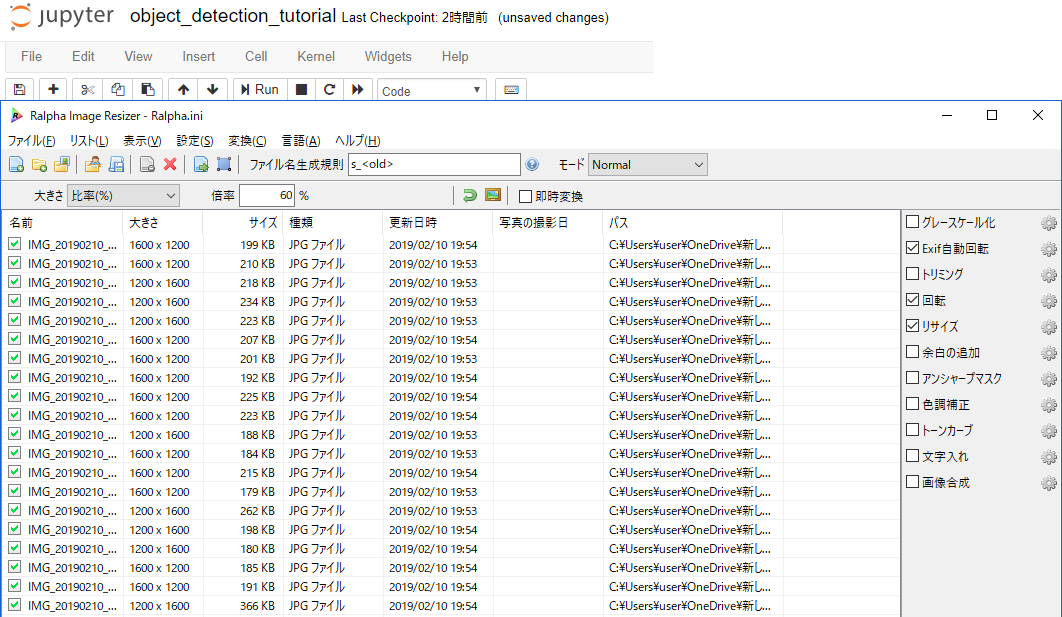

今度はちょっと画像を増やしてみるかー。同じ画像を加工して水増しする。これ使ってみます。

https://forest.watch.impress.co.jp/library/software/ralpha/大きさと左右反転とアンシャープマスクかけた。アンシャープマスクは逆にシャープにする方にかけたけど。

画像が40枚になったのでまたTFRecord生成するとこから。

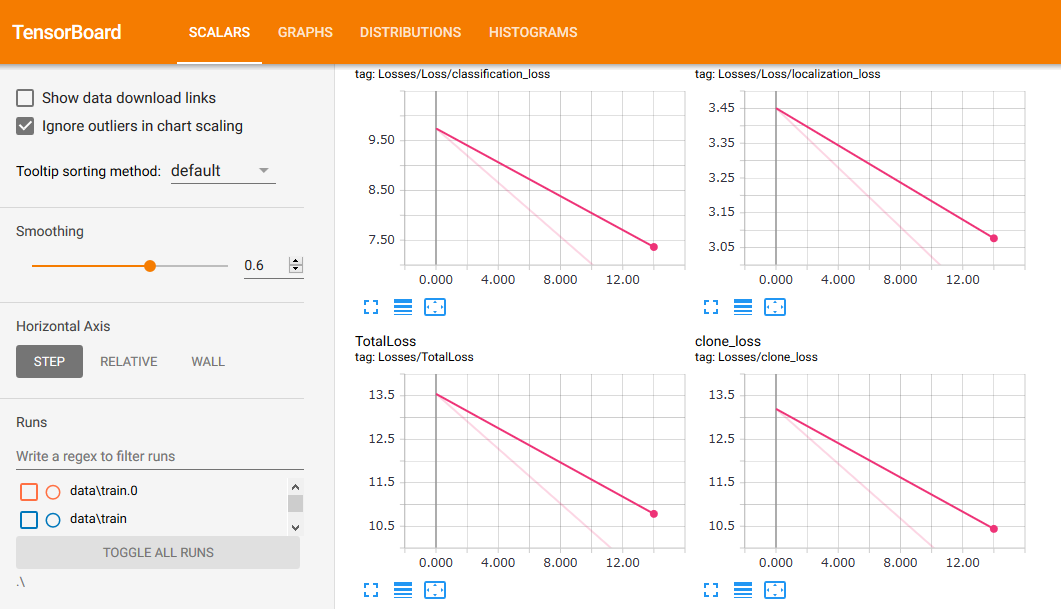

そしてstepや閾値を調整しつつ、何度かやり直す。python -m object_detection.legacy.train --logtostderr --pipeline_config_path=.\data\ssd_mobilenet_v1_kame.config --train_dir=.\data\train.3 ... INFO:tensorflow:Recording summary at step 0. INFO:tensorflow:Recording summary at step 0. INFO:tensorflow:global step 1: loss = 13.1957 (32.560 sec/step) INFO:tensorflow:global step 1: loss = 13.1957 (32.560 sec/step) INFO:tensorflow:global step 2: loss = 12.0376 (7.747 sec/step) INFO:tensorflow:global step 2: loss = 12.0376 (7.747 sec/step) INFO:tensorflow:global step 3: loss = 11.0935 (4.905 sec/step) INFO:tensorflow:global step 3: loss = 11.0935 (4.905 sec/step) INFO:tensorflow:global step 4: loss = 11.2538 (4.690 sec/step) INFO:tensorflow:global step 4: loss = 11.2538 (4.690 sec/step) INFO:tensorflow:global step 5: loss = 10.3707 (5.106 sec/step) INFO:tensorflow:global step 5: loss = 10.3707 (5.106 sec/step) INFO:tensorflow:global step 6: loss = 10.8260 (5.108 sec/step) INFO:tensorflow:global step 6: loss = 10.8260 (5.108 sec/step) INFO:tensorflow:global step 7: loss = 9.6286 (5.158 sec/step) INFO:tensorflow:global step 7: loss = 9.6286 (5.158 sec/step) INFO:tensorflow:global step 8: loss = 9.9401 (5.029 sec/step) INFO:tensorflow:global step 8: loss = 9.9401 (5.029 sec/step) INFO:tensorflow:global step 9: loss = 9.3262 (5.330 sec/step) INFO:tensorflow:global step 9: loss = 9.3262 (5.330 sec/step) INFO:tensorflow:global step 10: loss = 9.5075 (5.274 sec/step) INFO:tensorflow:global step 10: loss = 9.5075 (5.274 sec/step) INFO:tensorflow:global step 11: loss = 8.8719 (5.587 sec/step) INFO:tensorflow:global step 11: loss = 8.8719 (5.587 sec/step) INFO:tensorflow:global step 12: loss = 7.7746 (5.752 sec/step) INFO:tensorflow:global step 12: loss = 7.7746 (5.752 sec/step) ...なんかキレイに収束していって面白い。今度は期待できるか?

なおこの様子はtensorboardというのでモニターできるみたい。

tensorboard --logdir .\ --host 0.0.0.0ってresearch/object-detectionディレクトリで実行したらトレーニングの様子が可視化された。細かい設定何もいらないのか。楽だな。学習中のPCが重いので別PCからモニタリングしてます。

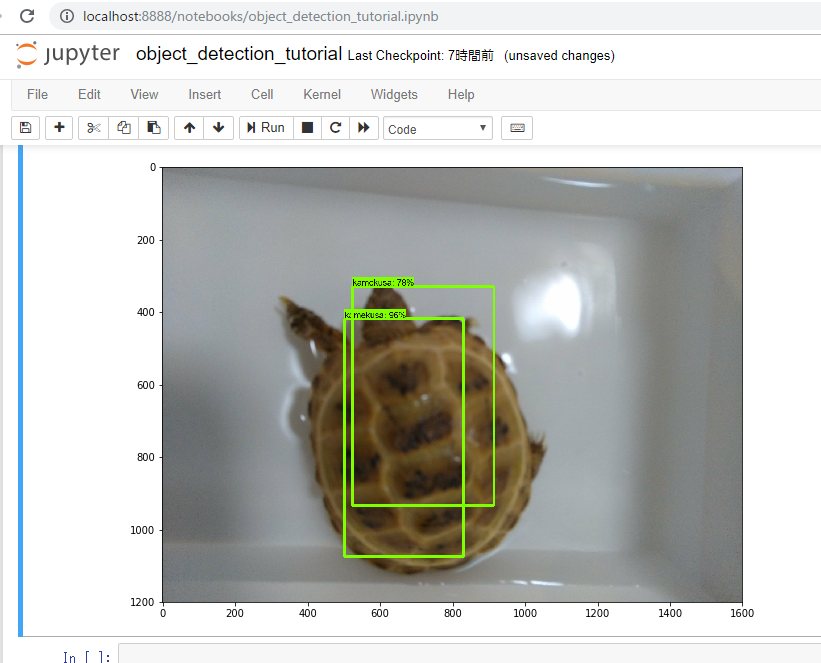

で、とりあえずの結果としては・・

とりあえずこんな所でしょうか。。

- 甲羅を中心に狭めの範囲タグ付けして

- num_stepsは200

- 画像は加工後の20枚だけ

しかし、もうちょっといろんなバリエーションで認識してくれないとツライなー。甲羅は特徴的だし、比較的捉えやすいかと思ったんだけど。

ひとまず記事としてはここまでとしますが、10000stepくらいまでトレーニング続けてどうなるかを試してみようと思います。基本、時系列で記事書いてるのでまとまりわるいですが、躓いた点とか試行錯誤してるあたりを参考にしていただければいいなと思っております。

- 投稿日:2019-02-11T21:58:57+09:00

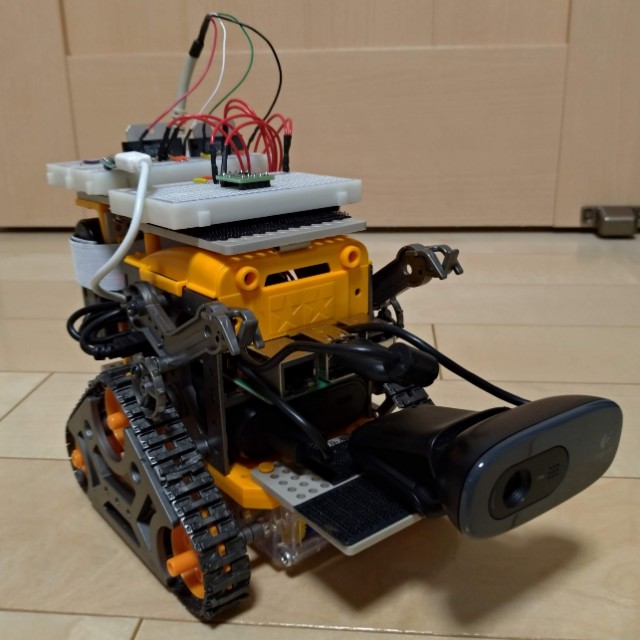

Raspberry Pi 3 Mobel B+とカムプログラムを使ってロボット作成

はじめに

Raspberry Pi 3 Model B+をタミアのカムプログラムロボット(ガンメタ/オレンジ)に組み込んでロボットを作成しました。外観と動作はこんな感じです。

なるべく外観を崩さないようにしたかったのですが、いろいろと詰め込んでゴテゴテしてます(笑)

ComeRob動作の様子(Youtubeへ移動します)

機能一覧

現在は下記の機能があります。

- TA7291Pを使ったモータ制御を行い、前進、後退、左旋回、右旋回、ブレーキ、ストップを行う

- モータ動作モードや出力(%)と作動時間(秒)を記述したCSVファイルを読み込み、その内容で動作させる

- MPU9250による加速度、ジャイロ、地磁気の取得し、取得した加速度などに時間と動作モードと追加してCSVファイルへの保存

動作は指定された出力と秒数で、前進、後退、左旋回、右旋回を行うだけです。

Webカムはいまのところ、動作はしていません(2019/02現在)。今回はブレッドボードの配線や、GPIOの接続などの説明はしておらず、ソフトウェア関連の記述になっています。作ってソフト関連のところが一番苦労したので、こちらを先に公開しようと考えました。

これだけ見れば動作できるようには出来ないようにはならんだろうな。。と思います。

ハードウェア周りはまた別の機会に記述したいと思います。参考にした本やサイト

実装の際、下記の本やサイトを参考にしました。

■ カラー図解 最新 Raspberry Piで学ぶ電子工作(ブルーバックス刊)

こちらの本、すごく参考になりました。

はじめは記述されたとおりに、LEDをチカチカさせて遊ぶのから初めて、段々と複数のLEDを光らせたり、ランダム間隔で点滅させたりと、各記述を色々と改良して試しました。

モータドライバの制御やGPIO配線はほぼこちらの書籍の内容になっています。■Rasberry pi 3でストロベリー・リナックス社製の「MPU-9250 9軸センサモジュール (メーカー品番:MPU-9250)」を使う

Qiitaのboyaki_machineさんのページです。

加速度センサやジャイロはデータシートなどみて何とかできたのですが、地磁気センサーの制御はこのページのコードを利用しております。

はじめは地磁気センサー周りだけ移植しようかとも思ったのですが、加速度などもそのまま利用させて頂いています。RaspberryPiの設定について

RaspberryPiのOS設定などは、詳しく解説しているページが多々ありますので、そちらを参照してください。

特殊な設定はしていなく、

- piユーザのパスワード変更と自動ログインの停止

- CUIログインの設定

- sshの有効化

- GPIOの有効化

の設定を行っています。

利用OSはNOOBSです。Raspbianでも動作すると思います。

将来的にOpenCVをいれてWebカムによる画像認識と動作確認をしたいので、GUIも利用できるようフルパッケージ版にしました。今のところGUIの機能はいらないの、起動はCUIベースに変更しています。動作コード

プログラムは仕事でやったことがあるのですが、pythonはほとんど使ったことがなく、ここまでのステップ数のプログラムを書いたのは初めてなので、問題がある部分もあると思います。

その点はご了承ください。下記のコードに3つになります。

- motor_sensor.py(メインプログラム)

- mpu9250.py (MPU9250制御クラス)

- ta7291p.py (TA7291P制御クラス)

メインプログラムや各制御クラスはRaspberry Piの下記のディレクトリに配置して動作させています。

/home/pi/Documents/RaspberryPi_DIY/CamRobo/MPU9250やTA7291Pはクラスライブラリにしています。motor_sensor.pyと同じディレクトリに置いてください。

main code

motor_sensor.py#!/usr/bin/python3 # -*- coding: utf_8 -*- from time import sleep,time from datetime import datetime import sys import threading import ta7291p import mpu9250 # MPU9250 センサクラス class mpu9250_sesor(threading.Thread): def __init__(self, mode): threading.Thread.__init__(self) # mpu9250センサオブジェクト self.sensor = mpu9250.SL_MPU9250(0x68,1) # 動作モード self.mode = mode def run(self): try: # センサ初期化 self.sensor.resetRegister() self.sensor.powerWakeUp() self.sensor.setAccelRange(8,True) self.sensor.setGyroRange(1000,True) self.sensor.setMagRegister('100Hz','16bit') # 静止モード's'に設定 self.mode = 's' # センセデータ出力ファイル filename = '/home/pi/Documents/RaspberryPi_DIY/CamRobo/data/gryo_accel_{!s}.csv'.format(datetime.now().strftime("%Y%m%d%H%M%S")) with open(filename,'w') as f: f.write('tm,ax,ay,az,gx,gy,gz,mx,my,mz,md\n') while True: # 動作モードが終了以外の場合 if self.mode != 'd': now = time() acc = self.sensor.getAccel() gyr = self.sensor.getGyro() mag = self.sensor.getMag() f.write('{0:.7f},' '{1[0]:.7f},{1[1]:.7f},{1[2]:.7f},' '{2[0]:.7f},{2[1]:.7f},{2[2]:.7f},' '{3[0]:.7f},{3[1]:.7f},{3[2]:.7f},' '{4}\n' .format(now,acc,gyr,mag,self.mode)) sleep(0.1) # 動作モードが終了の場合は whileを抜ける else: break except KeyboardInterrupt: pass finally: self.sensor.finallySensor() # モータ制御オブジェクト PWMを 50Hzに指定 motor = ta7291p.TB_TA7291P(50) # 動作ファイルの指定がない場合は、move_list.csvを読み込む if len(sys.argv) < 2: file_path = './move_list.csv' else: file_path = sys.argv[1] try: # MPU9205センサスレッド生成、モードを初期化(i)で設定 acc_gyr_mag_senser = mpu9250_sesor('i') # MPU9250 センサスタート acc_gyr_mag_senser.start() # MPU9250センサの初期が終わるまでwait while acc_gyr_mag_senser.mode == 'i': sleep(0.1) # 静止モードに設定 acc_gyr_mag_senser.mode = 's' # モーター電源On motor.power_on() with open(file_path) as f: for line in f: move_data = line.rstrip('\n').split(',') # MPU9250にセンサモードを設定 acc_gyr_mag_senser.mode = move_data[0] # 動作モードごとに呼び出し先を変更 if move_data[0] == 'fw': # 前進 motor.mv_forward(float(move_data[1]), float(move_data[2])) elif move_data[0] == 'bw': # 後退 motor.mv_backword(float(move_data[1]), float(move_data[2])) elif move_data[0] == 'rt': # 右旋回 motor.mv_right_turn(float(move_data[1]), float(move_data[2])) elif move_data[0] == 'lt': # 左旋回 motor.mv_left_turn(float(move_data[1]), float(move_data[2])) elif move_data[0] == 'b': # ブレーキ motor.mv_brake(float(move_data[2])) elif move_data[0] == 's': # Stop motor.mv_stop(float(move_data[2])) # MPU9250センサを終了モートに設定 acc_gyr_mag_senser.mode = 'd' except KeyboardInterrupt: pass finally: # モーター電源off motor.power_down()mpu9250 センサ制御

MPU9250とTA7291Pの制御クラスは下記になります。

MPU9250のコードはboyaki_machineさんのコードについて次の部分を修正しています。

1. python3で動作するようにする

2. Ctrl+Cで停止させた場合なので終了処理の追加

3. 単体動作時にセンサから取得したデータを表示するprint文を変更しています。mpu9250.py#!/usr/bin/python3 -u # -*- coding: utf-8 -*- import smbus import time # Strawberry Linux社の「MPU-9250」からI2Cでデータを取得するクラス(python 2) # https://strawberry-linux.com/catalog/items?code=12250 # # 2016-05-03 Boyaki Machine # オリジナル # 2019-02-09 K-ponta # Python3 に対応。 # MPU9250 終了処理を追加。finallySensor() # class SL_MPU9250: # 定数宣言 REG_PWR_MGMT_1 = 0x6B REG_INT_PIN_CFG = 0x37 REG_GYRO_CONFIG = 0x1B REG_ACCEL_CONFIG1 = 0x1C REG_ACCEL_CONFIG2 = 0x1D MAG_MODE_POWERDOWN = 0 # 磁気センサpower down MAG_MODE_SERIAL_1 = 1 # 磁気センサ8Hz連続測定モード MAG_MODE_SERIAL_2 = 2 # 磁気センサ100Hz連続測定モード MAG_MODE_SINGLE = 3 # 磁気センサ単発測定モード MAG_MODE_EX_TRIGER = 4 # 磁気センサ外部トリガ測定モード MAG_MODE_SELF_TEST = 5 # 磁気センサセルフテストモード MAG_ACCESS = False # 磁気センサへのアクセス可否 MAG_MODE = 0 # 磁気センサモード MAG_BIT = 14 # 磁気センサが出力するbit数 offsetRoomTemp = 0 tempSensitivity = 333.87 gyroRange = 250 # 'dps' 00:250, 01:500, 10:1000, 11:2000 accelRange = 2 # 'g' 00:±2, 01:±4, 10:±8, 11:±16 magRange = 4912 # 'μT' offsetAccelX = 0.0 offsetAccelY = 0.0 offsetAccelZ = 0.0 offsetGyroX = 0.0 offsetGyroY = 0.0 offsetGyroZ = 0.0 # コンストラクタ def __init__(self, address, channel): self.address = address self.channel = channel self.bus = smbus.SMBus(self.channel) self.addrAK8963 = 0x0C # Sensor initialization self.resetRegister() self.powerWakeUp() self.gyroCoefficient = self.gyroRange / float(0x8000) # センシングされたDecimal値をdpsに変換する係数 self.accelCoefficient = self.accelRange / float(0x8000) # センシングされたDecimal値をgに変換する係数 self.magCoefficient16 = self.magRange / 32760.0 # センシングされたDecimal値をμTに変換する係数(16bit時) self.magCoefficient14 = self.magRange / 8190.0 # センシングされたDecimal値をμTに変換する係数(14bit時) # レジスタを初期設定に戻します。 def resetRegister(self): if self.MAG_ACCESS == True: self.bus.write_i2c_block_data(self.addrAK8963, 0x0B, [0x01]) self.bus.write_i2c_block_data(self.address, 0x6B, [0x80]) time.sleep(0.1) # DLPF設定 self.bus.write_i2c_block_data(self.address, 0x1A, [0x00]) self.MAG_ACCESS = False time.sleep(0.1) # レジスタをセンシング可能な状態にします。 def powerWakeUp(self): # PWR_MGMT_1をクリア self.bus.write_i2c_block_data(self.address, self.REG_PWR_MGMT_1, [0x00]) time.sleep(0.1) # I2Cで磁気センサ機能(AK8963)へアクセスできるようにする(BYPASS_EN=1) self.bus.write_i2c_block_data(self.address, self.REG_INT_PIN_CFG, [0x02]) self.MAG_ACCESS = True time.sleep(0.1) # センサの終了処理 def finallySensor(self): self.bus.write_i2c_block_data(self.address, self.REG_PWR_MGMT_1, [0x80]) time.sleep(0.1) self.bus.write_i2c_block_data(self.address, self.REG_PWR_MGMT_1, [0x40]) time.sleep(0.1) # 磁気センサのレジスタを設定する def setMagRegister(self, _mode, _bit): if self.MAG_ACCESS == False: # 磁気センサへのアクセスが有効になっていないので例外を上げる raise Exception('001 Access to a sensor is invalid.') _writeData = 0x00 # 測定モードの設定 if _mode=='8Hz': # 連続測定モード1 _writeData = 0x02 self.MAG_MODE = self.MAG_MODE_SERIAL_1 elif _mode=='100Hz': # 連続測定モード2 _writeData = 0x06 self.MAG_MODE = self.MAG_MODE_SERIAL_2 elif _mode=='POWER_DOWN': # パワーダウンモード _writeData = 0x00 self.MAG_MODE = self.MAG_MODE_POWERDOWN elif _mode=='EX_TRIGER': # 外部トリガ測定モード _writeData = 0x04 self.MAG_MODE = self.MAG_MODE_EX_TRIGER elif _mode=='SELF_TEST': # セルフテストモード _writeData = 0x08 self.MAG_MODE = self.MAG_MODE_SELF_TEST else: # _mode='SINGLE' # 単発測定モード _writeData = 0x01 self.MAG_MODE = self.MAG_MODE_SINGLE # 出力するbit数 if _bit=='14bit': # 14bit出力 _writeData = _writeData | 0x00 self.MAG_BIT = 14 else: # _bit='16bit' # 16bit 出力 _writeData = _writeData | 0x10 self.MAG_BIT = 16 self.bus.write_i2c_block_data(self.addrAK8963, 0x0A, [_writeData]) # 加速度の測定レンジを設定します。広レンジでは測定粒度が荒くなります。 # val = 16, 8, 4, 2(default) def setAccelRange(self, val, _calibration=False): # ±2g (00), ±4g (01), ±8g (10), ±16g (11) if val==16 : self.accelRange = 16 _data = 0x18 elif val==8 : self.accelRange = 8 _data = 0x10 elif val==4 : self.accelRange = 4 _data = 0x08 else: self.accelRange = 2 _data = 0x00 self.bus.write_i2c_block_data(self.address, self.REG_ACCEL_CONFIG1, [_data]) self.accelCoefficient = self.accelRange / float(0x8000) time.sleep(0.1) # オフセット値をリセット(過去のオフセット値が引き継がれないように) self.offsetAccelX = 0 self.offsetAccelY = 0 self.offsetAccelZ = 0 # 本当はCalibrationしたほうが良いと思うけれど、時間もかかるし。 if _calibration == True: self.calibAccel(1000) return # ジャイロの測定レンジを設定します。広レンジでは測定粒度が荒くなります。 # val= 2000, 1000, 500, 250(default) def setGyroRange(self, val, _calibration=False): if val==2000: self.gyroRange = 2000 _data = 0x18 elif val==1000: self.gyroRange = 1000 _data = 0x10 elif val==500: self.gyroRange = 500 _data = 0x08 else: self.gyroRange = 250 _data = 0x00 self.bus.write_i2c_block_data(self.address, self.REG_GYRO_CONFIG, [_data]) self.gyroCoefficient = self.gyroRange / float(0x8000) time.sleep(0.1) # オフセット値をリセット(過去のオフセット値が引き継がれないように) self.offsetGyroX = 0 self.offsetGyroY = 0 self.offsetGyroZ = 0 # 本当はCalibrationしたほうが良いのだが、時間もかかるし。 if _calibration == True: self.calibGyro(1000) return # 加速度センサのLowPassFilterを設定します。 # def setAccelLowPassFilter(self,val): #センサからのデータはそのまま使おうとするとunsignedとして扱われるため、signedに変換(16ビット限定) def u2s(self,unsigneddata): if unsigneddata & (0x01 << 15) : return -1 * ((unsigneddata ^ 0xffff) + 1) return unsigneddata # 加速度値を取得します def getAccel(self): data = self.bus.read_i2c_block_data(self.address, 0x3B ,6) rawX = self.accelCoefficient * self.u2s(data[0] << 8 | data[1]) + self.offsetAccelX rawY = self.accelCoefficient * self.u2s(data[2] << 8 | data[3]) + self.offsetAccelY rawZ = self.accelCoefficient * self.u2s(data[4] << 8 | data[5]) + self.offsetAccelZ return rawX, rawY, rawZ # ジャイロ値を取得します。 def getGyro(self): data = self.bus.read_i2c_block_data(self.address, 0x43 ,6) rawX = self.gyroCoefficient * self.u2s(data[0] << 8 | data[1]) + self.offsetGyroX rawY = self.gyroCoefficient * self.u2s(data[2] << 8 | data[3]) + self.offsetGyroY rawZ = self.gyroCoefficient * self.u2s(data[4] << 8 | data[5]) + self.offsetGyroZ return rawX, rawY, rawZ def getMag(self): if self.MAG_ACCESS == False: # 磁気センサが有効ではない。 raise Exception('002 Access to a sensor is invalid.') # 事前処理 if self.MAG_MODE==self.MAG_MODE_SINGLE: # 単発測定モードは測定終了と同時にPower Downになるので、もう一度モードを変更する if self.MAG_BIT==14: # 14bit出力 _writeData = 0x01 else: # 16bit 出力 _writeData = 0x11 self.bus.write_i2c_block_data(self.addrAK8963, 0x0A, [_writeData]) time.sleep(0.01) elif self.MAG_MODE==self.MAG_MODE_SERIAL_1 or self.MAG_MODE==self.MAG_MODE_SERIAL_2: status = self.bus.read_i2c_block_data(self.addrAK8963, 0x02 ,1) if (status[0] & 0x02) == 0x02: # データオーバーランがあるので再度センシング self.bus.read_i2c_block_data(self.addrAK8963, 0x09 ,1) elif self.MAG_MODE==self.MAG_MODE_EX_TRIGER: # 未実装 return elif self.MAG_MODE==self.MAG_MODE_POWERDOWN: raise Exception('003 Mag sensor power down') # ST1レジスタを確認してデータ読み出しが可能か確認する。 status = self.bus.read_i2c_block_data(self.addrAK8963, 0x02 ,1) while (status[0] & 0x01) != 0x01: # データレディ状態まで待つ time.sleep(0.01) status = self.bus.read_i2c_block_data(self.addrAK8963, 0x02 ,1) # データ読み出し data = self.bus.read_i2c_block_data(self.addrAK8963, 0x03 ,7) rawX = self.u2s(data[1] << 8 | data[0]) # 下位bitが先 rawY = self.u2s(data[3] << 8 | data[2]) # 下位bitが先 rawZ = self.u2s(data[5] << 8 | data[4]) # 下位bitが先 st2 = data[6] # オーバーフローチェック if (st2 & 0x08) == 0x08: # オーバーフローのため正しい値が得られていない raise Exception('004 Mag sensor over flow') # μTへの変換 if self.MAG_BIT==16: # 16bit出力の時 rawX = rawX * self.magCoefficient16 rawY = rawY * self.magCoefficient16 rawZ = rawZ * self.magCoefficient16 else: # 14bit出力の時 rawX = rawX * self.magCoefficient14 rawY = rawY * self.magCoefficient14 rawZ = rawZ * self.magCoefficient14 return rawX, rawY, rawZ def getTemp(self): data = self.bus.read_i2c_block_data(self.address, 0x65 ,2) raw = data[0] << 8 | data[1] return ((raw - self.offsetRoomTemp) / self.tempSensitivity) + 21 def selfTestMag(self): print ("start mag sensor self test") self.setMagRegister('SELF_TEST','16bit') self.bus.write_i2c_block_data(self.addrAK8963, 0x0C, [0x40]) time.sleep(1.0) data = self.getMag() print (data) self.bus.write_i2c_block_data(self.addrAK8963, 0x0C, [0x00]) self.setMagRegister('POWER_DOWN','16bit') time.sleep(1.0) print ("end mag sensor self test") return # 加速度センサを較正する # 本当は緯度、高度、地形なども考慮する必要があるとは思うが、簡略で。 # z軸方向に正しく重力がかかっており、重力以外の加速度が発生していない前提 def calibAccel(self, _count=1000): print ("Accel calibration start") _sum = [0,0,0] # 実データのサンプルを取る for _i in range(_count): _data = self.getAccel() _sum[0] += _data[0] _sum[1] += _data[1] _sum[2] += _data[2] # 平均値をオフセットにする self.offsetAccelX = -1.0 * _sum[0] / _count self.offsetAccelY = -1.0 * _sum[1] / _count self.offsetAccelZ = -1.0 * ((_sum[2] / _count ) - 1.0) # 重力分を差し引く # オフセット値をレジスタに登録したいけれど、動作がわからないので実装保留 print ("Accel calibration complete") return self.offsetAccelX, self.offsetAccelY, self.offsetAccelZ # ジャイロセンサを較正する # 各軸に回転が発生していない前提 def calibGyro(self, _count=1000): print ("Gyro calibration start") _sum = [0,0,0] # 実データのサンプルを取る for _i in range(_count): _data = self.getGyro() _sum[0] += _data[0] _sum[1] += _data[1] _sum[2] += _data[2] # 平均値をオフセットにする self.offsetGyroX = -1.0 * _sum[0] / _count self.offsetGyroY = -1.0 * _sum[1] / _count self.offsetGyroZ = -1.0 * _sum[2] / _count # オフセット値をレジスタに登録したいけれど、動作がわからないので実装保留 print ("Gyro calibration complete") return self.offsetGyroX, self.offsetGyroY, self.offsetGyroZ if __name__ == "__main__": sensor = SL_MPU9250(0x68,1) try: sensor.resetRegister() sensor.powerWakeUp() sensor.setAccelRange(8,True) #sensor.setAccelRange(8,False) sensor.setGyroRange(1000,True) sensor.setMagRegister('100Hz','16bit') # sensor.selfTestMag() while True: now = time.time() acc = sensor.getAccel() gyr = sensor.getGyro() mag = sensor.getMag() print ('{0[0]:.7f},{0[1]:.7f},{0[2]:.7f},' '{1[0]:.7f},{1[1]:.7f},{1[2]:.7f},' '{2[0]:.7f},{2[1]:.7f},{2[2]:.7f}'.format(acc,gyr,mag)) sleepTime = 0.1 - (time.time() - now) if sleepTime < 0.0: continue time.sleep(sleepTime) except KeyboardInterrupt: pass finally: sensor.finallySensor()TA7291P モータドライバ制御

TA7291Pの制御クラスは下記のコードになります。

Raspberry Piで学ぶ電子工作のコードを参考に、Python3化や各動作を関数化したりしています。ta7291p.py#!/usr/bin/python3 -u # -*- coding: utf_8 -*- import RPi.GPIO as GPIO from time import sleep class TB_TA7291P: # 定数宣言 GPIO_L1 = 24 # 左モーター Line1 GPIO_L2 = 25 # 左モーター Line2 GPIO_R1 = 22 # 右モーター Line1 GPIO_R2 = 23 # 右モーター Line2 MAX_POWER = 75 # PWM最大値 これ以上の値が入力されて場合はこの値に変更 # コンストラクタ def __init__(self, pwm_hz = 50): GPIO.setmode(GPIO.BCM) # Left Sied GPIO.setup(self.GPIO_L1, GPIO.OUT) GPIO.setup(self.GPIO_L2, GPIO.OUT) # Right Side GPIO.setup(self.GPIO_R1, GPIO.OUT) GPIO.setup(self.GPIO_R2, GPIO.OUT) # self.L_p0 = GPIO.PWM(self.GPIO_L1, pwm_hz) # GPIO=24、周波数50Hz self.L_p1 = GPIO.PWM(self.GPIO_L2, pwm_hz) # GPIO=25、周波数50Hz # self.R_p0 = GPIO.PWM(self.GPIO_R1, pwm_hz) # GPIO=24、周波数50Hz self.R_p1 = GPIO.PWM(self.GPIO_R2, pwm_hz) # GPIO=25、周波数50Hz # Power ON def power_on(self): self.L_p0.start(100) self.L_p1.start(100) self.R_p0.start(100) self.R_p1.start(100) # Power Down def power_down(self): ### 終了処理 self.L_p0.stop(0) self.L_p1.stop(0) self.R_p0.stop(0) self.R_p1.stop(0) GPIO.cleanup() # 前進 def mv_forward(self, power_gain, op_time): # 出力が100% を超えていた場合は 100% にする if ( power_gain > 100 ): power_gain = 100 # 左右前進 self.L_p0.ChangeDutyCycle(self.MAX_POWER * power_gain / 100) self.L_p1.ChangeDutyCycle(0) self.R_p0.ChangeDutyCycle(self.MAX_POWER * power_gain / 100) self.R_p1.ChangeDutyCycle(0) # op_time秒維持 sleep(op_time) return # 後退 def mv_backword(self, power_gain, op_time): # 出力が100% を超えていた場合は 100% にする if ( power_gain > 100 ): power_gain = 100 # 左右 back self.L_p0.ChangeDutyCycle(0) self.L_p1.ChangeDutyCycle(self.MAX_POWER * power_gain / 100) self.R_p0.ChangeDutyCycle(0) self.R_p1.ChangeDutyCycle(self.MAX_POWER * power_gain / 100) # op_time秒維持 sleep(op_time) return # 左旋回 def mv_left_turn(self, power_gain, op_time): # 出力が100% を超えていた場合は 100% にする if ( power_gain > 100 ): power_gain = 100 # 左後退、右前進 self.L_p0.ChangeDutyCycle(0) self.L_p1.ChangeDutyCycle(self.MAX_POWER * power_gain / 100) self.R_p0.ChangeDutyCycle(self.MAX_POWER * power_gain / 100) self.R_p1.ChangeDutyCycle(0) # op_time秒維持 sleep(op_time) return # 右旋回 def mv_right_turn(self, power_gain, op_time): # 出力が100% を超えていた場合は 100% にする if ( power_gain > 100 ): power_gain = 100 # 左前進、右後退 self.L_p0.ChangeDutyCycle(self.MAX_POWER * power_gain / 100) self.L_p1.ChangeDutyCycle(0) self.R_p0.ChangeDutyCycle(0) self.R_p1.ChangeDutyCycle(self.MAX_POWER * power_gain / 100) # op_time秒維持 sleep(op_time) return # Brake def mv_brake(self, op_time = 0.1): # Brake self.L_p0.ChangeDutyCycle(self.MAX_POWER) self.L_p1.ChangeDutyCycle(self.MAX_POWER) self.R_p0.ChangeDutyCycle(self.MAX_POWER) self.R_p1.ChangeDutyCycle(self.MAX_POWER) # op_time秒維持、標準は0.1秒 sleep(op_time) return # Stop def mv_stop(self, op_time = 0.1): # Stop self.L_p0.ChangeDutyCycle(0) self.L_p1.ChangeDutyCycle(0) self.R_p0.ChangeDutyCycle(0) self.R_p1.ChangeDutyCycle(0) # op_time秒維持、省略した場合は0.1秒 sleep(op_time) return if __name__ == "__main__": moter = TB_TA7291P(50) try: # 動作テスト # 電源On moter.power_on() # 前進 出力100%で2秒間 moter.mv_forward(100,2) # 停止 1秒間 moter.mv_stop(1) # 後退 出力100%で2秒間 moter.mv_backword(100,2) # 停止 1秒間 moter.mv_stop(1) # 左旋回 出力100%で3秒間 moter.mv_left_turn(100,3) # 停止 省略した場合は0.1秒間 moter.mv_stop() # 右旋回 出力100%で3秒間 moter.mv_right_turn(100,3) # 停止 省略した場合は0.1秒間 moter.mv_stop() # 前進 出力100%で2秒間 moter.mv_forward(100,2) # ブレーキ 1秒間 moter.mv_brake(1) # 後退 出力100%で2秒間 moter.mv_backword(100,2) # 停止 1秒間 moter.mv_stop(1) except KeyboardInterrupt: pass finally: # 電源Off moter.power_down()起動方法

motor_sensor.py に実行権限を与えておきます。

motor_sensor.py は、引数で動作指定CSVファイルを指定しないと、 motor_sensor.py と同じ場所の move_list.csv を読み込みに行くので、起動前に move_list.csv を次項目の「動作指定CSVファイル」の書式に作成してください。

MPU9250センサがファイルを出力するディレクトリも作成しておきます。$ chmod +x ./motor_sensor.py $ vi move_list.csv $ mkdir data $ ./motor_sensor.py任意の動作指定CSVを指定する場合は下記にように指定してください。

$ ./motor_sensor.py ./move_list_2.csv動作指定CSVファイル

motor_sensor.pyは、引数に動作ファイルを指定しないと、同じ場所に置かれた move_list.csv を読み込むようになっています。

move_list.csv の記述例は下記のとおりです。move_list.csvfw,100,3 s,,1 bw,100,3 s,,1 rt,100,5 s,,1 lt,100,5 s,,1 fw,100,3 s,,1 bw,100,3 s,,1 rt,100,5 s,,1 lt,100,5 s,,1 fw,100,3 s,,1 bw,100,3 s,,1 rt,100,5 s,,1 lt,100,5 s,,1動作指定CSVファイルは下記のような書式で記述します。

動作モード 書式 記述例 前進 fw,出力(%),動作時間(秒) fw,100,5 後退 bw,出力(%),動作時間(秒) bw,80,10 左旋回 lt,出力(%),動作時間(秒) lt,100,15 右旋回 rt,出力(%),動作時間(秒) rt,70,10 ブレーキ b,,動作時間(秒) b,,1 ストップ s,,動作時間(秒) s,,0.1 MPU9250センサの出力結果

実行が終了すると、dataディレクトリに gryo_accel_YYYYMMDDHHMISS.csv というファイル名で実行結果が出力されます。

MPU9250センサの出力結果例

gryo_accel_20190211171249.csvtm,ax,ay,az,gx,gy,gz,mx,my,mz,md 1549872769.3912337,-0.0016426,-0.0022119,0.9971360,0.1807556,-0.0335693,0.0632019,3.2986569,1.1995116,52.4786325,s 1549872769.5083649,-0.0275215,-0.0832666,0.9876145,2.8663025,2.0111084,0.6125183,4.1982906,2.3990232,50.3794872,fw 1549872769.6260414,0.0999199,-0.0019678,0.9761399,-1.5587463,5.7037354,1.0397644,3.2986569,2.9987790,50.9792430,fw 1549872769.7436359,0.0051934,-0.0881494,0.7981614,0.1807556,-3.3905029,2.3825378,2.6989011,1.4993895,51.8788767,fw ・ ・ 中略 ・ ・ 1549872781.9190757,-0.0411934,-0.0073389,0.7908372,-6.6246643,4.6661377,5.2511902,3.1487179,1.9492063,52.0288156,bw 1549872782.0366840,-0.1910957,0.0590674,1.0276536,3.8733826,-3.8177490,4.7934265,2.2490842,3.1487179,51.1291819,bw 1549872782.1542869,0.0618340,0.1633154,0.9378098,-3.2982483,3.1402588,-0.1504211,2.6989011,3.2986569,51.5789988,bw 1549872782.2611101,-0.1989082,0.0949561,0.8975266,-2.0165100,2.9571533,2.5046082,2.6989011,1.7992674,51.2791209,bw 1549872782.3787096,0.0545098,-0.1186670,1.0347336,-6.3194885,6.6802979,3.9084167,1.7992674,2.0991453,50.9792430,bw各値は下記のとおりです。

UNIX時間,X軸加速度,Y軸加速度,Z軸加速度,X角速度,Y角速度,Z角速度,X地磁気,Y地磁気,Z地磁気,動作モードこれのデータを元に機械学習して、自分がどのように動作しているのか認識できるよう出来ないかな〜、と漠然と考えています。

データにばらつきが多いので、果たしでできるかどうか分かりませんが。。おわりに

取り急ぎ、自己満足的な備忘録的な内容になっていると思います。

当初の目的が、動作中の挙動データがほしかったので、しばらくはこちらで色々と試して見たいと思います。

- 投稿日:2019-02-11T20:36:22+09:00

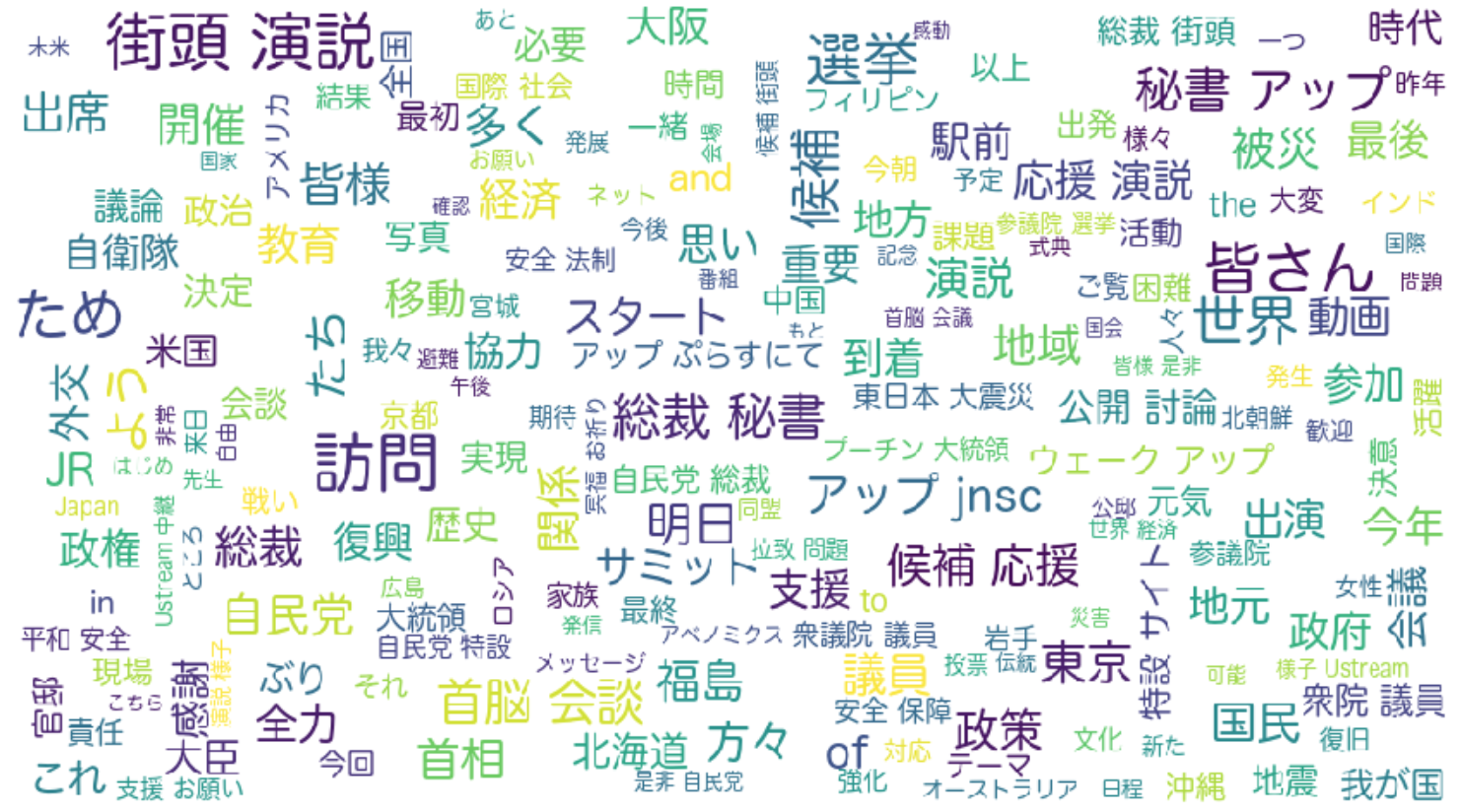

SentiWordNet を日本語化する

Sentiment Analysisに使えるデータセットとしてSentiWordNetというものがあります。これは、概念 (synset) ごとにポジティブ値とネガティブ値、そして例文がついています。具体的には以下のようになっています。

a 00001740 0.125 0 able#1 (usually followed by `to') having the necessary means or skill or know-how or authority to do something; "able to swim"; "she was able to program her computer"; "we were at last able to buy a car"; "able to get a grant for the project" a 00002098 0 0.75 unable#1 (usually followed by `to') not having the necessary means or skill or know-how; "unable to get to town without a car"; "unable to obtain funds"しかし日本語版が提供されていないので、今回はこれを無理やり日本語化しようと思います。

やり方は単純に日本語WordNetのDBを利用してSentiWordNetのsynsetから日本語の見出し語を取得して、例文はGoogle Apps Scriptを使って翻訳します。

コードはこちら

https://gist.github.com/ikegami-yukino/2a5ed3fd3ccde2938f020e47a8e4c9af

実行するには、SentiWordnet 3.0と日本語WordNetのDB (Japanese Wordnet and English WordNet in an sqlite3 databaseって書いてあるやつ) のダウンロードと、Google Apps ScriptのPlease_write_hereの部分を書き換えるのと、requestsのインストールが必要です。実行すると以下のような結果が得られます。

00001740-a 可能 0.125 0 泳げる,彼女は自分のコンピューターをプログラムできた,ついに車を買うことができました,プロジェクトの助成金を得ることができる 00002098-a できない 0 0.75 車なしでは町に行けない,資金を獲得できないただし例文の翻訳が下記のように微妙なことが多々あります。

古い世界をかき回した活発な議論によって触れられないそのささいな地方主義でシチュー 彼の頭は種を蒔くために行ってタンポポのようにあいまい 部屋は窒息していた - 暑くて空気のないまた、英語から日本語に訳す際にニュアンスが変わってしまう言葉があったりするので、このデータをそのままつかうのではなく、シードとして誤りを正すなり除外するなりしたほうがいいと思います。お金があれば翻訳処理の箇所を有償サービスのものに書き換えてみるのも手です。

- 投稿日:2019-02-11T20:35:31+09:00

ブーストラップ法:データに正しい意味づけをするための手法

はじめに

こんばんは。最近統計学をやってますが、如何せん時間に理解のかかる分野ですね(▽)

統計学はデータから導き出す論理なので、最近覚えたPythonと組み合わせて検証なんか面白いのではないかと思って定期的にやることにしました。ブーストラップ法についてです(^0^)ブーストラップ法について

ブートストラップ法とは簡単にいうと、標本から母集団の性質を推定するための方法です(なので母集団の統計量が未知の時によく使います)。標本集団から標本集団と同じ数だけランダムに値を再抽出し、新しいデータセットを取得し統計値を計算し、これを何回も繰り返し行います。

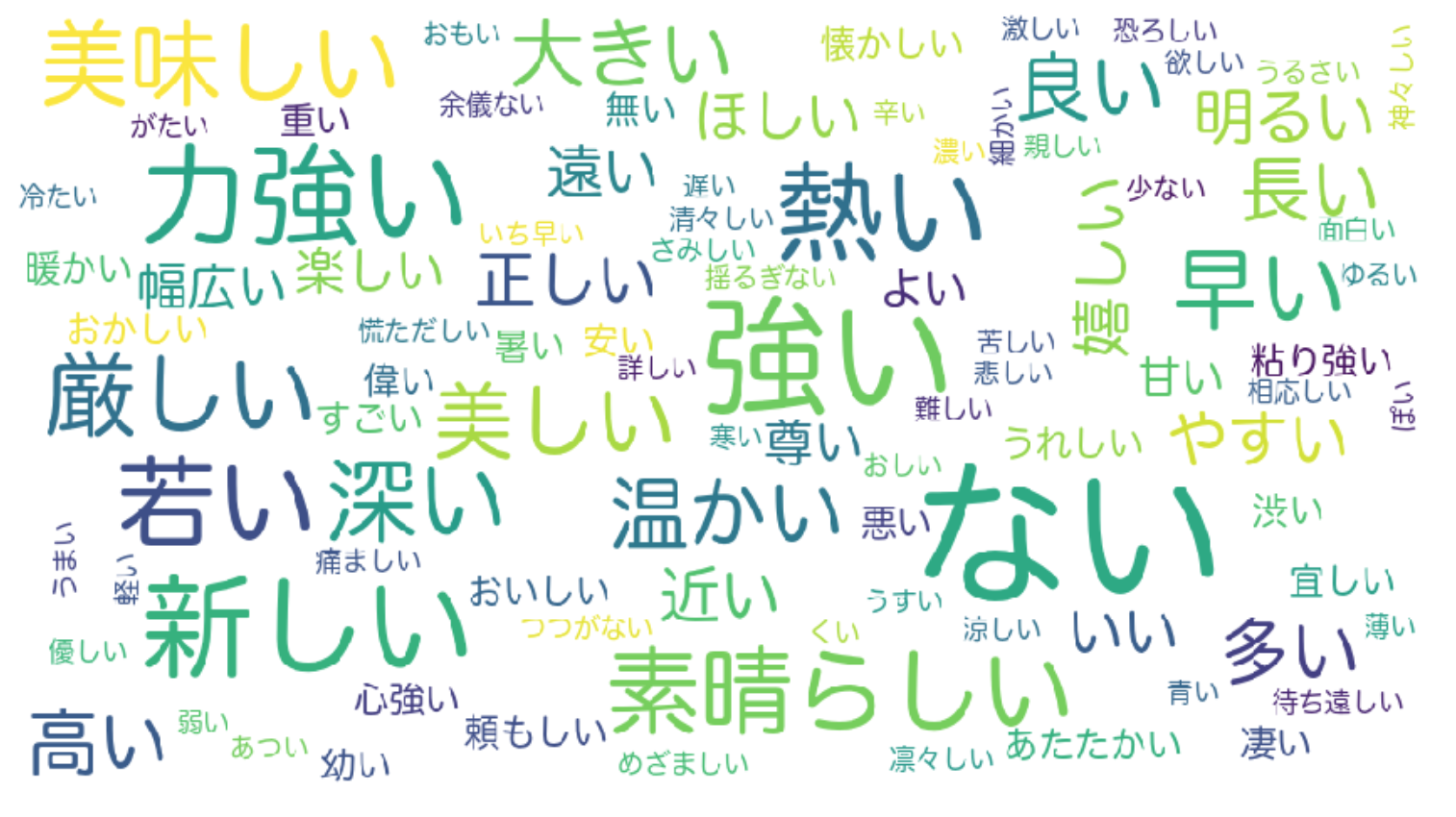

母集団に属する複雑なパラメータ(相関係数やオッズ比など)に対して標準誤差や信頼区間を求めたりすることが可能で、実用的な方法といえます。今回はデータから算出した相関係数について、どのくらい信頼できるのかを調べました。相関係数

相関係数はある2つのデータについて、どれだけ関連性が高いかを示す指標です。

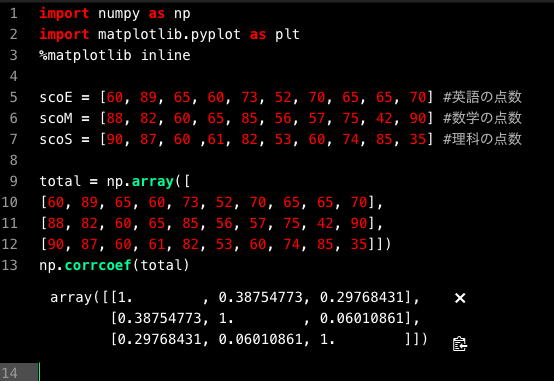

数式はこのようになります。数式だけを見るとなかなか難しそうですが、各値の「平均との差」同士を掛け合わせて合計した共分散を各データの標準偏差で割ればも止まるので、比較的算出は楽です。ある2変数データがあるとしましょう。例えば10人の生徒が居るとします。英語・数学・理科それぞれのテストを測定した結果、それぞれの点数が出席番号一人目から数えて

英語:[60, 89, 65, 60, 73, 52, 70, 65, 65, 70]

数学:[80, 82, 60, 65, 85, 56, 57, 75, 42, 90]

理科:[90, 87, 60 ,61, 82, 53, 60, 74, 85, 35]

となったとしましょう。英語と数学、理科について、それぞれがどの程度関係性があるかをそう関係係数を用いてPythonで算出してみましょう。

corref.pyimport numpy as np import matplotlib.pyplot as plt %matplotlib inline scoE = [60, 89, 65, 60, 73, 52, 70, 65, 65, 70] #英語の点数 scoM = [88, 82, 60, 65, 85, 56, 57, 75, 42, 90] #数学の点数 scoS = [90, 87, 60 ,61, 82, 53, 60, 74, 85, 35] #理科の点数 total = np.array([ [60, 89, 65, 60, 73, 52, 70, 65, 65, 70], [88, 82, 60, 65, 85, 56, 57, 75, 42, 90], [90, 87, 60, 61, 82, 53, 60, 74, 85, 35]]) np.corrcoef(total)Numpyのcorrcoef関数を用いると行列式で結果が帰ってきます。

簡単なコードで実装できましたb

相関係数は

英語-数学で0.3875

英語-理科で0.2977

数学-理科で0.0601

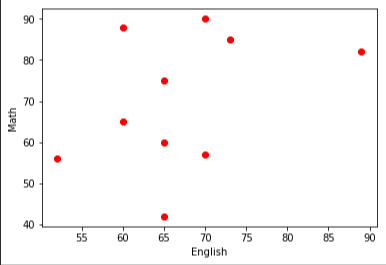

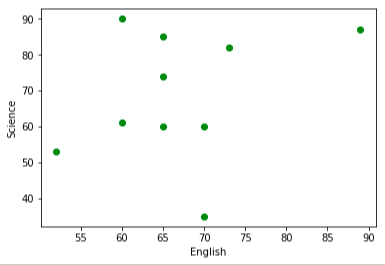

となり、英語と数学の相関が最も高いことがわかりました!(行列の対角成分は1となってますが、自分自身との相関なので自動的に1となります)本当に相関係数は正しい結論が出ているのか?

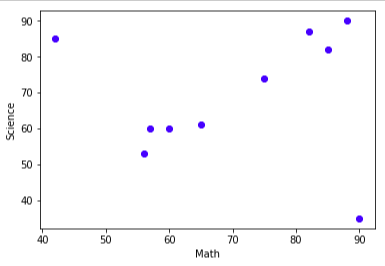

この相関の順番で本当に良いのか?ということすが、このデータに関しては実際にプロットした図をみると違和感を覚えませんかね。

bootstrup.pyimport numpy as np import matplotlib.pyplot as plt %matplotlib inline scoE = [60, 89, 65, 60, 73, 52, 70, 65, 65, 70] #英語の点数 scoM = [88, 82, 60, 65, 85, 56, 57, 75, 42, 90] #数学の点数 scoS = [90, 87, 60 ,61, 82, 53, 60, 74, 85, 35] #理科の点数 total = np.array([ [60, 89, 65, 60, 73, 52, 70, 65, 65, 70], [88, 82, 60, 65, 85, 56, 57, 75, 42, 90], [90, 87, 60, 61, 82, 53, 60, 74, 85, 35]]) np.corrcoef(total) plt.scatter(scoE, scoM,color = "red") plt.xlabel("English") plt.ylabel("Math") plt.show() plt.scatter(scoE, scoS, color = "green") plt.xlabel("English") plt.ylabel("Science") plt.show() plt.scatter(scoM, scoS, color = "blue") plt.xlabel("Math") plt.ylabel("Science") plt.show()となります。実際プロットしてみるとなんか数学と理科が一番関係してそうじゃないですか!?ってことなんですね。。。

違和感を感じた方は、おそらく数学ー理科への直線の当てはまりがとても良さそうなことだと思います。左上、右下の問題児が値を狂わせるだけだと考えます。ブーストラップ法は特徴量の誤差を評価するためにある。

ブーストラップ法の意味は、非復元無作為抽出を何回も繰り返して標本をたくさん作ることで誤差や信頼区間を求めることができるので、

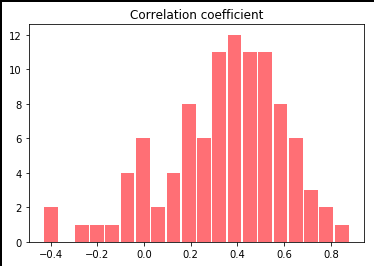

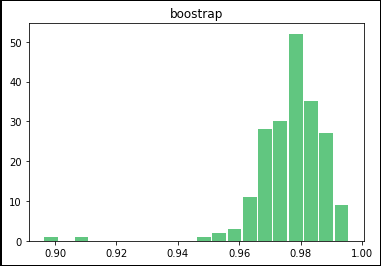

数学ー英語の相関係数rの算出を繰り返し、得られた相関係数のヒストグラムを描きます。bootstrup.pyimport numpy as np import matplotlib.pyplot as plt %matplotlib inline from numpy import random scoE = np.array([60, 89, 65, 60, 73, 52, 70, 65, 65, 70]) #英語の点数 scoM = np.array([88, 82, 60, 65, 85, 56, 57, 75, 42, 90]) #数学の点数 scoS = np.array([90, 87, 60 ,61, 82, 53, 60, 74, 85, 35]) #理科の点数 r_list = [] scoE_data = [] scoM_data = [] for i in range(0,100): for j in range(0,10): #データから10個のデータをランダムに取り出し標本を作成 var = np.random.randint(0,10) scoE_data.append(scoE[var]) scoM_data.append(scoM[var]) r = np.corrcoef(scoE_data, scoM_data) #作られた標本を元に相関係数を導出 r_list.append(r[0][1]) #相関係数を"相関係数のリスト"に代入 scoE_data.clear() #初期化 scoM_data.clear() #初期化 print(r_list) plt.hist(r_list, bins=20, rwidth = 0.9, color = "red", alpha = 0.5) plt.title("Correlation coefficient(English-Math)") plt.show()ランダムに作った標本の相関係数が100個されました。

[0.15585253823785258, 0.4305950697037106, -0.03605950604170644, 0.6895914209391649, 0.31730006314271886, 0.3571133940151882, 0.19235034767504772, 0.6604428333327486, 0.34624057748664877, 0.58739740964641, 0.3923342604650358, 0.34982802529568724, 0.37654394258141777, 0.6823344142547625, 0.26931232680365996, 0.3945405713525839, 0.5473013360492976, 0.3972558346301867, -0.014104654480949838, 0.5976257570137701, 0.5372925887633204, 0.28752828548647047, 0.5283345806099249, 0.5940113092694755, 0.7879208402738033, 0.6494747564288043, 0.13714668859593104, -0.07916220211899541, 0.4323235027266908, 0.2981580800528894, -0.036130190979291356, 0.38462886076620495, -0.08602450166292225, 0.1605332861541743, 0.26495611732346275, 0.007258756085075637, 0.4850878590607039, 0.5271967063712417, 0.0560651964634963, 0.5370778152226662, 0.6631130755480596, 0.5518047537543804, -0.4138715864761385, 0.17880183606547947, 0.44587872593154515, 0.8786518859359814, 0.44663361008233027, -0.09199113478155758, 0.44206830104754385, 0.17317850286085323, 0.3527569359486347, 0.02903453532831167, 0.30324100615147653, 0.4659062252828043, 0.36579811733823675, 0.6172409065635549, -0.4304239561846442, 0.4674885654245649, 0.0026228406936778105, -0.16976162750429294, 0.4964958991584344, -0.02845184525323593, 0.2192234013728081, 0.43728466018406714, 0.39454114048797484, 0.5467962835249239, 0.3236567706128534, 0.4905233568089641, 0.25853628119575633, 0.795733061984808, -0.2750759839004001, 0.23758912621891137, 0.5917957647188727, 0.4048812700603928, 0.29588321456141475, 0.5051473660742645, 0.4371408890294217, 0.5345353329276067, 0.31393863261724697, 0.1396781204218693, 0.28503328929367666, 0.16255482611670974, 0.5529714214125769, 0.5610424848640276, 0.2204529677799291, 0.3224797592194247, 0.6352813771554283, 0.3976137186707352, 0.578025141200671, 0.7141681567115036, 0.37172280357440474, 0.15806257086130274, 0.40112964046440924, 0.3112260142848983, 0.5069334332226477, 0.6549800690567563, -0.07955443225108468, -0.12012013025444407, 0.1825061363337386, 0.47319527315037974]これだけではわけわからないのでヒストグラムで表しました(^▽^)

平均が0.4の近くに寄っていますね。先ほど導出した相関係数が0.38だったので

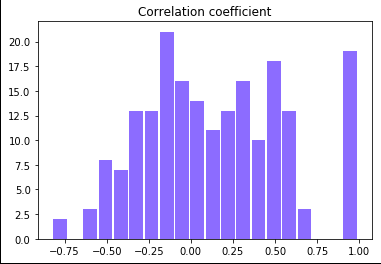

理論値を中心とした正規分布に近い形になっていますね。次に先ほど違和感のあった数学ー理解の導出です。(サンプルコードはほぼ同じなので省略しました)

こちらは正規分布っぽい形ではありますが、裾が広がっていることがわかりますね。

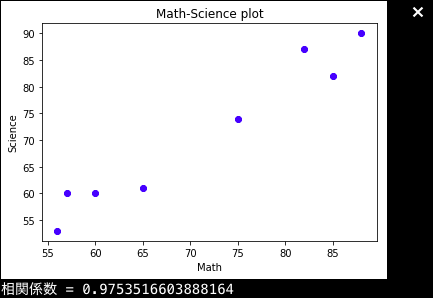

そして、分散も大きいので、信頼区間も狭いことがわかります。ちなみにですが、先ほどの数学ー理科の問題児を度外視したグラフはこのようになり、

plot2.pyimport numpy as np import matplotlib.pyplot as plt %matplotlib inline scoM = [88, 82, 60, 65, 85, 56, 57, 75] #数学の点数 scoS = [90, 87, 60 ,61, 82, 53, 60, 74] #理科の点数 plt.scatter(scoM, scoS, color = "blue") plt.xlabel("Math") plt.ylabel("Science") plt.title("Math-Science plot") plt.show()ブーストラップ法による測定値をヒストグラムに直すと、非常に分散の小さい正規分布になります。

まとめ

ブーストラップ法は、複雑なパラメーターの誤差や信頼区間を求めるためにあるそうです。そして、同じ相関係数を示場合でも、標本の分布によって標準誤差などは違ってくるようです。他にも実用的な測定法があれば載せていく予定なので見ていただければと思いますm(_ _)m

- 投稿日:2019-02-11T20:35:31+09:00

ブーストラップ法:統計量を導き出すための手法

はじめに

こんばんは。最近統計学をやってますが、如何せん理解に時間のかかる分野ですね。。

統計学はデータから導き出す論理なので、最近覚えたPythonと組み合わせて検証なんか面白いのではないかと思って定期的にやることにしました。ブーストラップ法についてです(^0^)ブーストラップ法について

ブートストラップ法とは簡単にいうと、標本から母集団の性質を推定するための方法です(なので母集団の統計量が未知の時によく使います)。標本集団から標本集団と同じ数だけランダムに値を再抽出し、新しいデータセットを取得し統計値を計算し、これを何回も繰り返し行います。

母集団に属する複雑なパラメータ(相関係数やオッズ比など)に対して標準誤差や信頼区間を求めたりすることが可能で、実用的な方法といえます。今回はデータから算出した相関係数について、どのくらい信頼できるのかを調べました。相関係数

相関係数はある2つのデータについて、どれだけ関連性が高いかを示す指標です。

数式だけを見るとなかなか難しそうですが、各値の「平均との差」同士を掛け合わせて合計した共分散を各データの標準偏差で割ればも止まるので、比較的算出は楽です。

ある2変数データがあるとしましょう。例えば10人の生徒が居るとします。英語・数学・理科それぞれのテストを測定した結果、それぞれの点数が出席番号一人目から数えて

英語:[60, 89, 65, 60, 73, 52, 70, 65, 65, 70]

数学:[80, 82, 60, 65, 85, 56, 57, 75, 42, 90]

理科:[90, 87, 60 ,61, 82, 53, 60, 74, 85, 35]

となったとしましょう。英語と数学、理科について、それぞれがどの程度関係性があるかをそう関係係数を用いてPythonで算出してみましょう。

corref.pyimport numpy as np import matplotlib.pyplot as plt %matplotlib inline scoE = [60, 89, 65, 60, 73, 52, 70, 65, 65, 70] #英語の点数 scoM = [88, 82, 60, 65, 85, 56, 57, 75, 42, 90] #数学の点数 scoS = [90, 87, 60 ,61, 82, 53, 60, 74, 85, 35] #理科の点数 total = np.array([ [60, 89, 65, 60, 73, 52, 70, 65, 65, 70], [88, 82, 60, 65, 85, 56, 57, 75, 42, 90], [90, 87, 60, 61, 82, 53, 60, 74, 85, 35]]) np.corrcoef(total)Numpyのcorrcoef関数を用いると行列式で結果が帰ってきます。

簡単なコードで実装できましたb

相関係数は

英語-数学で0.3875

英語-理科で0.2977

数学-理科で0.0601

となり、英語と数学の相関が最も高いことがわかりました!(行列の対角成分は1となってますが、自分自身との相関なので自動的に1となります)本当に相関係数は正しい結論が出ているのか?

この相関の順番で本当に良いのか?ということすが、このデータに関しては実際にプロットした図をみると違和感を覚えませんかね。

bootstrup.pyimport numpy as np import matplotlib.pyplot as plt %matplotlib inline scoE = [60, 89, 65, 60, 73, 52, 70, 65, 65, 70] #英語の点数 scoM = [88, 82, 60, 65, 85, 56, 57, 75, 42, 90] #数学の点数 scoS = [90, 87, 60 ,61, 82, 53, 60, 74, 85, 35] #理科の点数 total = np.array([ [60, 89, 65, 60, 73, 52, 70, 65, 65, 70], [88, 82, 60, 65, 85, 56, 57, 75, 42, 90], [90, 87, 60, 61, 82, 53, 60, 74, 85, 35]]) np.corrcoef(total) plt.scatter(scoE, scoM,color = "red") plt.xlabel("English") plt.ylabel("Math") plt.show() plt.scatter(scoE, scoS, color = "green") plt.xlabel("English") plt.ylabel("Science") plt.show() plt.scatter(scoM, scoS, color = "blue") plt.xlabel("Math") plt.ylabel("Science") plt.show()となります。実際プロットしてみるとなんか数学と理科が一番関係してそうじゃないですか!?ってことなんですね。。。

違和感を感じた方は、おそらく数学ー理科への直線の当てはまりがとても良さそうなことだと思います。左上、右下の問題児が値を狂わせるだけだと考えます。ブーストラップ法は特徴量の誤差を評価するためにある。

ブーストラップ法の意味は、非復元無作為抽出を何回も繰り返して標本をたくさん作ることで誤差や信頼区間を求めることができたり、ヒストグラムに直すと信頼度が視覚的にわかるようになります。

```python:bootstrap.py

import numpy as np

import matplotlib.pyplot as plt

%matplotlib inline

from numpy import randomscoE = np.array([60, 89, 65, 60, 73, 52, 70, 65, 65, 70]) #英語の点数

scoM = np.array([88, 82, 60, 65, 85, 56, 57, 75, 42, 90]) #数学の点数

scoS = np.array([90, 87, 60 ,61, 82, 53, 60, 74, 85, 35]) #理科の点数r_list = []

scoE_data = []

scoM_data = []for i in range(0,100):

for j in range(0,10): #データから10個のデータをランダムに取り出し標本を作成

var = np.random.randint(0,10)

scoE_data.append(scoE[var])

scoM_data.append(scoM[var])r = np.corrcoef(scoE_data, scoM_data) #作られた標本を元に相関係数を導出 r_list.append(r[0][1]) #相関係数を"相関係数のリスト"に代入 scoE_data.clear() #初期化 scoM_data.clear() #初期化print(r_list)

plt.hist(r_list, bins=20, rwidth = 0.9, color = "red", alpha = 0.5)

plt.title("Correlation coefficient(English-Math)")

plt.show()

```

ランダムに作った標本の相関係数が100個されました。

[0.15585253823785258, 0.4305950697037106, -0.03605950604170644, 0.6895914209391649, 0.31730006314271886, 0.3571133940151882, 0.19235034767504772, 0.6604428333327486, 0.34624057748664877, 0.58739740964641, 0.3923342604650358, 0.34982802529568724, 0.37654394258141777, 0.6823344142547625, 0.26931232680365996, 0.3945405713525839, 0.5473013360492976, 0.3972558346301867, -0.014104654480949838, 0.5976257570137701, 0.5372925887633204, 0.28752828548647047, 0.5283345806099249, 0.5940113092694755, 0.7879208402738033, 0.6494747564288043, 0.13714668859593104, -0.07916220211899541, 0.4323235027266908, 0.2981580800528894, -0.036130190979291356, 0.38462886076620495, -0.08602450166292225, 0.1605332861541743, 0.26495611732346275, 0.007258756085075637, 0.4850878590607039, 0.5271967063712417, 0.0560651964634963, 0.5370778152226662, 0.6631130755480596, 0.5518047537543804, -0.4138715864761385, 0.17880183606547947, 0.44587872593154515, 0.8786518859359814, 0.44663361008233027, -0.09199113478155758, 0.44206830104754385, 0.17317850286085323, 0.3527569359486347, 0.02903453532831167, 0.30324100615147653, 0.4659062252828043, 0.36579811733823675, 0.6172409065635549, -0.4304239561846442, 0.4674885654245649, 0.0026228406936778105, -0.16976162750429294, 0.4964958991584344, -0.02845184525323593, 0.2192234013728081, 0.43728466018406714, 0.39454114048797484, 0.5467962835249239, 0.3236567706128534, 0.4905233568089641, 0.25853628119575633, 0.795733061984808, -0.2750759839004001, 0.23758912621891137, 0.5917957647188727, 0.4048812700603928, 0.29588321456141475, 0.5051473660742645, 0.4371408890294217, 0.5345353329276067, 0.31393863261724697, 0.1396781204218693, 0.28503328929367666, 0.16255482611670974, 0.5529714214125769, 0.5610424848640276, 0.2204529677799291, 0.3224797592194247, 0.6352813771554283, 0.3976137186707352, 0.578025141200671, 0.7141681567115036, 0.37172280357440474, 0.15806257086130274, 0.40112964046440924, 0.3112260142848983, 0.5069334332226477, 0.6549800690567563, -0.07955443225108468, -0.12012013025444407, 0.1825061363337386, 0.47319527315037974]これだけではわけわからないのでヒストグラムで表しました(^▽^)

平均が0.4の近くに寄っていますね。先ほど導出した相関係数が0.38だったので

理論値を中心とした正規分布に近い形になっていますね。次に先ほど違和感のあった数学ー理解の導出です。(サンプルコードはほぼ同じなので省略しました)

こちらは正規分布っぽい形ではありますが、裾が広がっていることがわかりますね。

そして、分散も大きいので、信頼区間も狭いことがわかります。ちなみにですが、先ほどの数学ー理科の問題児を度外視したグラフはこのようになり、

plot2.pyimport numpy as np import matplotlib.pyplot as plt %matplotlib inline scoM = [88, 82, 60, 65, 85, 56, 57, 75] #数学の点数 scoS = [90, 87, 60 ,61, 82, 53, 60, 74] #理科の点数 plt.scatter(scoM, scoS, color = "blue") plt.xlabel("Math") plt.ylabel("Science") plt.title("Math-Science plot") plt.show()ブーストラップ法による測定値をヒストグラムに直すと、非常に分散の小さい正規分布になります。

まとめ

ブーストラップ法は、複雑なパラメーターの誤差や信頼区間を求めるためにあるそうです。そして、同じ相関係数を示場合でも、標本の分布によって標準誤差などは違ってくるようです。他にも実用的な測定法があれば載せていく予定なので見ていただければと思いますm(_ _)m

- 投稿日:2019-02-11T20:26:30+09:00

Python機械学習プログラミング レポート

「Python機械学習プログラミング」Sebastian Raschka/Vahid Mirjalili著 株式会社インプレス

を読んだので、備忘録としてまとめておく。・Python機械学習プログラミング パーセプトロンの学習アルゴリズム

・Python機械学習プログラミング ADALINE

・Python機械学習プログラミング ADALINE 改良版

・Python機械学習プログラミング SBS

・Python機械学習プログラミング カーネル主成分分析

・Python機械学習プログラミング 単純な多数決分類器

- 投稿日:2019-02-11T20:22:24+09:00

Pythonで学ぶアルゴリズム(二分探索とデータ構造)

はじめに

本記事は、Pythonによるアルゴリズム(二分探索とデータ構造)の検証結果のまとめです。

仮説

二分探索をPyhtonで記述する場合、合わせてデータ構造を考慮すると、Pythonでもリストより配列の方が早いと考えました。配列の場合、連続的にメモリのアドレスを確保し、ランダムアクセスやすべての要素を瞬時に調べることができるためです。対して、リストだと10番目の要素を読み取りたい場合は、9番目の要素を読み取って10番目の要素をたどる必要があるなど、総合的に配列の方が早いと思いました。

検証

1億個の要素から、目的の要素を見つけるのにかかる計算時間を計測します。

まずは、学習がてら単純探索より、二分探索が早いことを確認します。

次に、二分探索でリストと配列の場合での計算時間を計測します。環境:MacBook Air

プロセッサ名:Intel Core i5

プロセッサ速度:1.6 GHz

メモリ:4 GB単純探索

まずは、試しに以下のプログラムを実行し、単純探索でかかる計算時間を見てみます。

- simple_search.py

my_list = [] for i in range(100000000): my_list.append(i) def simple_search(list, item): for i in list: guess = i if guess == item: return guess print(simple_search(my_list, 77777777))timeコマンドでsimple_search.pyを実行したところ、約3分ほどかかりました。

$ time python3 simple_search.py 77777777 real 2m56.905s user 0m59.758s sys 0m53.585s二分探索

binary_search関数は、ソート済みの配列とアイテムを1つずつ受け取ります。そのアイテムが配列に含まれている場合、その位置(インデックス)の値を返します。

二分探索の検証では、binary_search.pyとbinary_search2.pyのプログラムを使用します。

binary_search関数の動きは同じですが、データを用意する方法をそれぞれ変えました。binary_search.pyは、forでデータを取り出し、リストに追加して用意します。

binary_search2.pyは、リスト内包表記でデータを取り出し、Numpyの一次元配列に格納して用意します。

- binary_search.py

my_list = [] for i in range(100000000): my_list.append(i) def binary_search(list, item): low = 0 high = len(list) - 1 while low <= high: mid = (low + high) //2 guess = list[mid] if guess == item: return mid if guess > item: high = mid -1 else: low = mid + 1 return None print (binary_search(my_list, 77777777))timeコマンドでsimple_search.pyを実行したところ、約1分半ほどかかりました。

想定通りですが、二分探索の方が単純探索より早いです。$ time python3 binary_search.py 77777777 real 1m34.540s user 0m43.687s sys 0m38.348s

- binary_search2.py

import numpy as np my_list = np.array([i for i in range(100000000)]) def binary_search(list, item): low = 0 high = len(list) - 1 while low <= high: mid = (low + high) //2 guess = list[mid] if guess == item: return mid if guess > item: high = mid -1 else: low = mid + 1 return None print (binary_search(my_list, 77777777))データをリスト内包表記にして、Numpyに置き換えて実行すれば、リストより早いと考えていましたが、1回目はリストの方に軍配が上がりました。

77777777 real 1m57.078s user 0m41.351s sys 0m43.036s検証結果

検証の精度を上げるため、それぞれ、3回ずつ実行した結果が以下になります。

二分探索(リスト) 二分探索(配列) 1回目:1m34.540s 1回目:1m57.078s 2回目:1m56.788s 2回目:1m24.709s 3回目:1m33.924s 3回目:1m28.110s 平均:1m41.751s 平均:1m36.632s 上記より、3回ずつ実行した結果の平均では、仮説の通りに二分探索(リスト)より、二分探索(配列)の早い(※)ことが確認できました。

(※)但し、1回目のタイムのように、キャッシュしていない状態だと、二分探索(リスト)の方が早い場合があります。

キャッシュメモリ

それぞれ、2回目以降のタイムが1回目より早くなっているのは、キャッシュするためです。

Intelプロセッサではキャッシュメモリが3段になっており、CPUがメモリアクセスを行うときに、まずはキャッシュメモリを見に行き、キャッシュメモリにない場合はメインメモリからデータをキャッシュメモリにコピーして使います。また、メインメモリにもキャッシュがあるので、同様の動きをします。

一般的には、キャッシュメモリへデータをコピーする場合は、ブロック呼ばれる単位で、まとめてコピーします。L1キャッシュの場合は64バイト単位でコピーされます。よって、配列のアクセスを行う場合は、連絡的にアクセスすると効率的です。

参考:今回のプログラムは単純ですが、コンテナや1GBのラズパイで試したところ、OOM Killerが発生しました。Numpyでメモリ消費を抑える場合は、dtype=np.float32を使用するといいかもしれません。

おわりに

プログラミングを学ぶことができるWebサービスはたくさんありますが、アルゴリズムについて教えてくれているサイトはあまりないような気がします。

プログラミング言語は、あくまでサービスを実現する手段なので、本質的なところを突き詰めるのもおもしろいです。次は、システムコールの呼びだしからメモリがどのように確保されるかなど、もっと掘り下げて検証したいと思います。

- 投稿日:2019-02-11T19:27:07+09:00

[Python]とにかくわかりやすく!Djangoでアプリ開発!ーその4ー

前回の記事

前回の記事→とにかくわかりやすく!Djangoでアプリ開発!ーその3ー

※前回までの記事、おかげさまでユーザーランキング7位までいきました。ありがとうございます。

本記事の目的

python初心者の方が、本記事を見たあとに、一人でアプリ開発できることを目的にしております。

※インストールや開発環境については記載しません環境

macOSX Sierra

python3.7

django 2.1.5前回まで

プロジェクトを立ち上げ(startproject)

→アプリの作成(startapp)

→view.pyを変更してレスポンスを書く

→urls.pyを修正する

→アプリの登録する

→index.html作る

→views.pyを直す

→htmlに変数入れる

→views.pyを直す

→複数ページ作るためにリンクつける

→views.pyを直す

→cssで装飾できるようにする

→htmlでフォームを作る

→views.pyを直す

→urls.pyを修正する

→やっぱりformクラスでフォームを作る

→views.pyを直す

→index.html直すとここまででした。

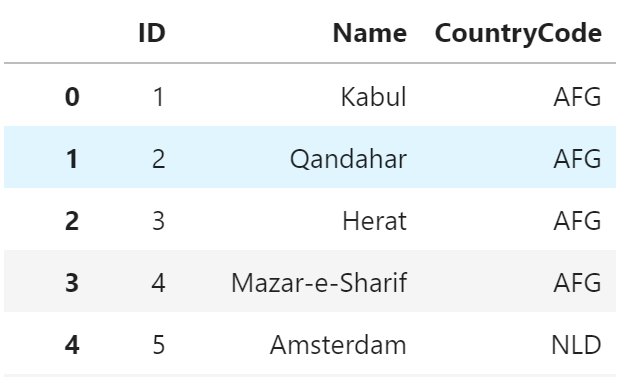

ここからはDBとの連携を記載していきます。

DBについて

Djangoで使えるSQLは以下になっています。

- MySQL:サーバータイプなのでwebサーバーとDBサーバーの間で通信を行います。

- PostgresQL:サーバータイプなのでwebサーバーとDBサーバーの間で通信を行います。

- SQLite:エンジンタイプなのでDBに直接アクセスを行います。

がDjangoにはすでにSQLiteが組み込まれています。そのファイルもすでにdb.sqliteとして用意されていますね。

DBの設定を見てみる

設定に関することなので、myapp/settings.pyを見てみます。

デフォルトで設定されている項目が2つあります。

DBへのアクセスに使われるENGINEとDBそのものの名前を表すNAMEです。

os.path.joinはディレクトリパスを繋げているだけなので難しくないですね。DATABASES = { 'default': { 'ENGINE': 'django.db.backends.sqlite3', 'NAME': os.path.join(BASE_DIR, 'db.sqlite3'), } }僕はPostgreSQLを使うことが多いので以下の設定にすることもあります。

settings.pyDATABASES = { 'default': { 'ENGINE': 'django.db.backends.postgresql', 'NAME': postgres, 'USER': ユーザー名, 'PASSWORD': パスワード, 'HOST': ホスト名, 'PORT': '5432', } }テーブルを作る

ユーザー情報を管理できるようにテーブルを作成してみたいと思います。

テーブル定義に関しては割愛しますが、以前投稿したこちらのDB構築の記事を参考にしてください。でここからが大事になってきます。

テーブル定義をした後にSQLでcreate文でテーブルを作る必要はなく、models.pyで定義をしておけば、自動で生成をしてくれます。便利ですね。

モデルでclassを作り、それのインスタンスをテーブルのレコードとして利用することができます。ということでmodels.pyを書き換えていきます。

今回はユーザー情報テーブルを作っていきます。冒頭にあるmodelsというクラスを継承して作成できるので簡単です。

__str__を用意して、内容をreturnで返せるようにしています。あとあとindex.htmlで{{}}で埋め込めます。models.pyfrom django.db import models class Touroku(models.Model): name = models.CharField(max_length=30) gender = models.BooleanField() age = models.IntegerField(default = 0) def __str__(self): return '<ID:'+str(self.id)+'> 名前:'+self.name+' ('+str(self.age)+'歳)'ここまでできたら、DBの立ち上げやアップデートに行うための「マイグレーション」を行います。

やることは2つだけ。「作成」と「適用」だけです。簡単です。

ターミナルで以下を打ち込みます。ディレクトリはmanage.pyがあるところです。$ python manage.py makemigrations #作成$ python manage.py migrate #適用 Operations to perform: Apply all migrations: admin, auth, contenttypes, sessions Running migrations: Applying contenttypes.0001_initial... OK Applying auth.0001_initial... OK Applying admin.0001_initial... OK Applying admin.0002_logentry_remove_auto_add... OK Applying admin.0003_logentry_add_action_flag_choices... OK Applying contenttypes.0002_remove_content_type_name... OK Applying auth.0002_alter_permission_name_max_length... OK Applying auth.0003_alter_user_email_max_length... OK Applying auth.0004_alter_user_username_opts... OK Applying auth.0005_alter_user_last_login_null... OK Applying auth.0006_require_contenttypes_0002... OK Applying auth.0007_alter_validators_add_error_messages... OK Applying auth.0008_alter_user_username_max_length... OK Applying auth.0009_alter_user_last_name_max_length Applying sessions.0001_initial... OKエラーがでなければOKです!一度管理ツールを使ってDBを確認しておきます。

ということで管理者を作成しておきます。

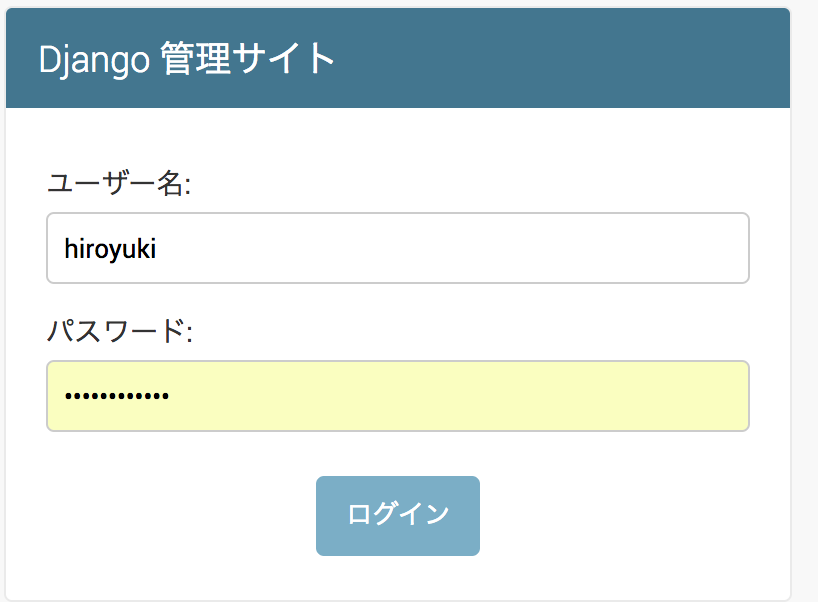

*パスワードが雑すぎて警告でてますが無視します。$ python manage.py createsuperuser ユーザー名 (leave blank to use 'hiropy'): hiroyuki メールアドレス: hogehoge@gmail.com Password: Password (again): このパスワードは メールアドレス と似すぎています。 このパスワードは短すぎます。最低 8 文字以上必要です。 Bypass password validation and create user anyway? [y/N]: y Superuser created successfully.次は管理ツールで先ほど作ったクラス(モデル)を使えるようにします。

admin.pyの中身を書き換えます。クラスを呼び出して、さらにadminのregisterメソッドを使ってクラスを登録します。from django.contrib import admin from .models import Touroku admin.site.register(Touroku)ここまできたらブラウザで127.0.0.8000/adminにアクセスします。毎度ですがrunserverしておいてください。

以下のような認証画面がでてきます。

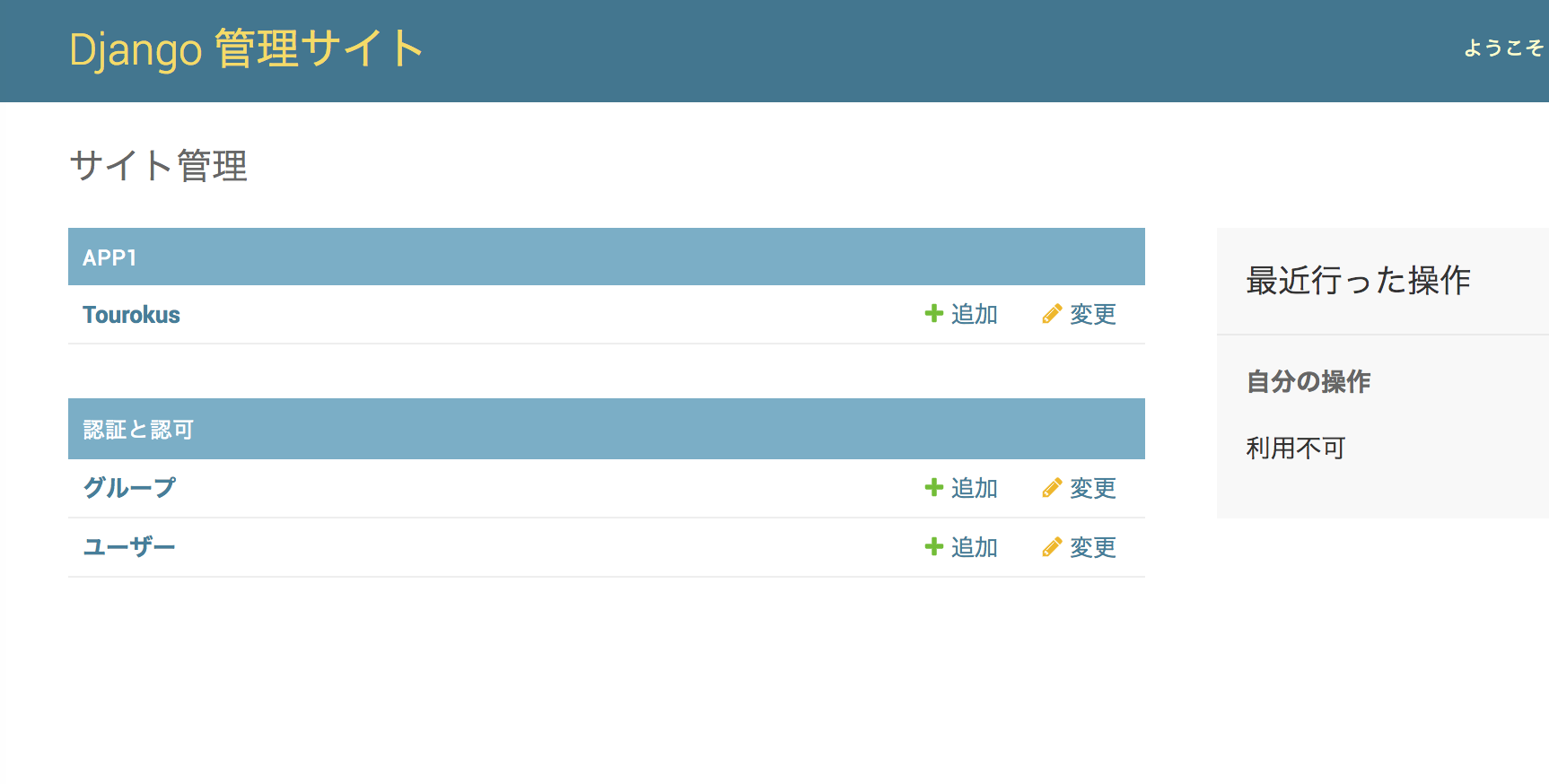

認証して、自身で定義したモデルが入っていればOKです!

あとは適当な名前で登録を行います。テストなのでなんでも。

ここで疑問に思った人がいるかと思います。「ID」っていつ振ったんだろうと。定義しなかったものです。

ここでマイグレーションによって実は生成されてた、app1/migration配下の0001_initial.pyをみてみます。

Migrationというものが作られていて、operationsという変数の中に、テーブルを作るための定義が記述されています。この中のidの部分をみてみるとAutoField(auto_created=Trueと記載されていることから、自動で割り振られていることがわかります。from django.db import migrations, models class Migration(migrations.Migration): initial = True dependencies = [ ] operations = [ migrations.CreateModel( name='Touroku', fields=[ ('id', models.AutoField(auto_created=True, primary_key=True, serialize=False, verbose_name='ID')), ('name', models.CharField(max_length=30)), ('gender', models.BooleanField()), ('age', models.IntegerField(default=0)), ], ), ]と少し話はそれましたが、ユーザーなどの追加に関してもこの管理ツールを使えば簡単に行うことができます。

この後のアプリ本体からDBにアクセスし、情報を表示させることに関しては少し長くなるので、次回の記事に記載していきます。

この記事はここまで

次回、続きを投稿していきます。

- 投稿日:2019-02-11T18:45:06+09:00

[2019年]raspberry pi初期設定(pipenv導入まで)

0.確認事項

ログインpassword, ネットワーク設定は初回起動時に設定済みとします。

使用機器は以下の通りです。・Windows10 Home

・Raspberry Pi 3 Model B+ (2018)$ llsb_release -a No LSB modules are available. Distributor ID: Raspbian Description: Raspbian GNU/Linux 9.6 (stretch) Release: 9.6 Codename: stretch1. SSH,VNC接続設定

ローカルPCからraspberry piを操作できるようにSSH,VNC接続環境を整えます。

Raspberry Pi へのリモート接続 を参考にします。

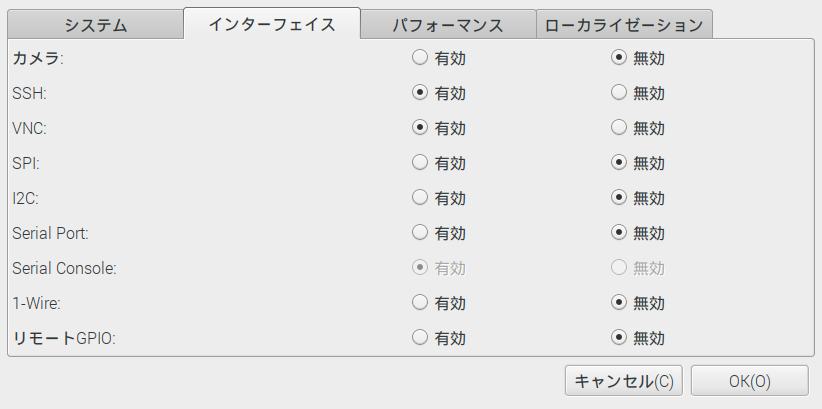

1.タスクバーから '設定>raspberry piの設定>インターフェイス タブを選択

以下のようにSSH,VNCを有効にチェックし、OKを押します。

2.ローカルからssh接続する

raspberry piでLxTerminalを開きifconfigコマンドでraspberry piのipアドレスをメモしておきます。$ ifconfig wlan0: inet 192.168.1.12 netmask 255.255.255.0 broadcast 192.168.1.255ローカルPCから、以下コマンドを実行することでraspberry piへ接続します。

$ ssh pi@192.168.1.123.ローカルからVNC接続する

VNC ViewerをローカルPCにインストールします。

VNC Viewerを起動しraspberry piのipアドレスで接続設定を行います。

認証画面でraspberry piのユーザID、ログインpasswordを入力して接続します。

以下の画面が出れば成功です。

2.ipアドレスを固定する

Raspberry PiのセットアップからPython実行環境構築とイメージファイルバックアップまで

の⑥IPアドレスを固定するを参考にします。1.dhcpcd.confを編集して固定する

$ sudo vi /etc/dhcpcd.conf #viエディタで設定ファイルを編集dhcpcd.confinterface wlan0 #有線なら「eth0」無線なら「wlan0」 static ip_address=192.168.1.12 #Raspberry PiのIP static routers=192.168.1.1 #ルーターのIP static domain_name_servers=192.168.1.1 #ルーターのIPCtrl+X → Y → Enter で保存して閉じる

$ sudo service dhcpcd reload #設定を反映する $ sudo reboot #再起動3.ソフトウェアを最新化する

以下コマンドでraspberry piの各ソフトウェアを最新化します。

$sudo apt update $sudo apt upgrade $sudo apt install rpi-update $sudo rpi-update $sudo reboot4.OSをバックアップする

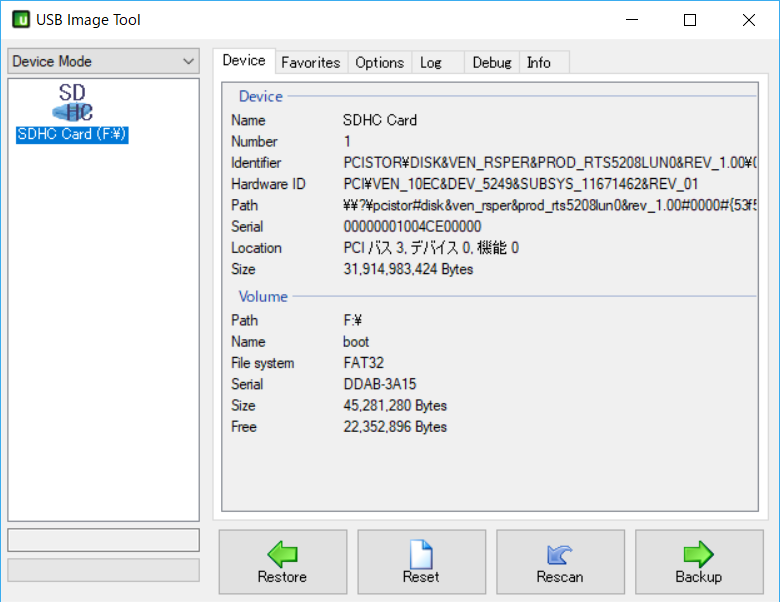

USB Image Toolを使用してOSをバックアップします。

USB Image ToolはSDカードをまるごとイメージファイルとしてバックアップしてくれるソフトです。

使い方は簡単です。1.バックアップする

ローカルPCにraspberry piのOSが入ったSDカードを接続してUSB Image Toolを起動します。

Backupボタンを押して任意のフォルダにイメージを保存します。2.リストアする時

・Resetボタンを押して、SDカードを初期化します。

・Restoreボタンを押して保存したイメージファイルをリストアします。5.sambaのインストール

sambaを使いローカルPCとraspberry piでファイル共有できるようにします。

$sudo apt-get install samba $sudo vi /etc/samba/smb.conf #設定ファイルの編集先頭行に以下を追加

smb.conf[global] workgroup=WORKGROUP dos charset = CP932 unix charset = utf-8 hosts allow = 192.168. #192.168.xx.xxのipのみアクセス許可 max log size =50 log file = /var/log/samba/log.%m security=user passdb backend=tdbsam [share] comment =share directory browseable=yes writable=yes path=/home/piローカルPCのネットワークアドレスに

\\192.168.1.12\shareと打つことでraspberry piのホームディレクトリにアクセスが可能になります。6.pyenv,pipenvをインストールする

raspberry piのpython実行環境は以下の通りです。

raspberry piでpython3.6以上を使用する場合pyenvのインストールが必要になります。

pipenvはプロジェクトごとにpython仮想環境を構築するアプリケーションです。$python -V Python 2.7.13 $python3 -V Python 3.5.31.pyenvインストール

raspberry piで以下を実行します。$ sudo apt install git $ git clone https://github.com/yyuu/pyenv.git ~/.pyenv $ echo 'export PYENV_ROOT="$HOME/.pyenv"' >> ~/.bash_profile $ echo 'export PATH="$PYENV_ROOT/bin:$PATH"' >> ~/.bash_profile $ echo 'eval "$(pyenv init -)"' >> ~/.bash_profile $ exec $SHELL $ sudo reboot#依存関係のあるライブラリをインストール $sudo apt-get install -y make build-essential libssl-dev zlib1g-dev libbz2-dev libreadline-dev libsqlite3-dev wget curl llvm libncurses5-dev libncursesw5-dev xz-utils tk-dev $sudo apt-get install libffi-devpyenvでpython3.7.0をインストールします。

$source ~/home/pi/.bash_profile #pyenvが読み込めない場合に実行 $pyenv install 3.7.0 #python 3.7.0をインストール $pyenv global 3.7.0 #Python 3.7.0をデフォルトのインタプリタとして設定以下になっていれば成功

$python3 -V python 3.7.02.pipenvのインストール

$pip install --upgrade pip $pip install pipenvpipenv使い方

$mkdir ./project1 #プロジェクトごとにディレクトリを作成 $cd ./project1 $pipenv install --python 3.7.0 #3.7.0で仮想環境構築 ローカルにpipfile, pipfile.lockが生成 $pipenv install <package_name> #仮想環境にパッケージのインストール #または $pip shell #仮想環境を実行 (project1)$ pip install <package_name> #仮想環境にパッケージのインストールおわり

以上でraspberry piの初期設定は終了です。

あとはお好きなタイミングでOSのバックアップを取ればいいかと思います。

お疲れ様でした。

- 投稿日:2019-02-11T18:44:08+09:00

im2col関数の理解

書籍「ゼロから作るディープラーニング」をもとに

畳み込みニューラルネットワーク(CNN、Convolutional Neural Network)を勉強しているのですが、途中に出てくるim2col関数というものについて理解が難しかったため、

自分なりの噛み砕きの経緯を書いてみました。もしもどなたかの参考になれば幸いです。

im2col関数について

CNNの畳み込み演算において複雑なループ処理を避けるため、

フィルター適用領域ごとに一列のデータになるよう変換する関数です。入力データとフィルターにこの関数を適用することで、

行列のドット演算で一気に畳み込み演算が行えます。オリジナルの実装

「ゼロから作る〜」で紹介されている実装はこのようなものです。

def im2col(input_data, filter_h, filter_w, stride=1, pad=0): N, C, H, W = input_data.shape out_h = (H + 2*pad - filter_h)//stride + 1 out_w = (W + 2*pad - filter_w)//stride + 1 img = np.pad(input_data, [(0,0), (0,0), (pad, pad), (pad, pad)], 'constant') col = np.zeros((N, C, filter_h, filter_w, out_h, out_w)) for y in range(filter_h): y_max = y + stride*out_h for x in range(filter_w): x_max = x + stride*out_w col[:, :, y, x, :, :] = img[:, :, y:y_max:stride, x:x_max:stride] col = col.transpose(0, 4, 5, 1, 2, 3).reshape(N*out_h*out_w, -1) return col書籍の説明を見ると目指すところは理解できるのですが、

このループ処理部分で行っている事がどうにも理解できませんでした。引っかかった点

y_maxとx_maxが何を意味しているのかよくわからない- imgのスライスで何を取り出しているのかよくわからない

y:y_max:stride,、x:x_max:strideって何?- フィルターサイズについてのループだけで処理できる理由がよくわからない

そこで、まずは自分なりに素朴な発想で実装してみました。

素朴な実装

フィルターを移動させるループ

→フィルタ内の各画素をコピーするループ

の順でx方向・y方向、4重ループ処理すればいけるはず...

という発想でforループ部分のみ変更してみたのが以下のim2col_slowです。def im2col_slow(input_data, filter_h, filter_w, stride=1, pad=0): N, C, H, W = input_data.shape out_h = (H + 2*pad - filter_h)//stride + 1 out_w = (W + 2*pad - filter_w)//stride + 1 img = np.pad(input_data, [(0,0), (0,0), (pad, pad), (pad, pad)], 'constant') col = np.zeros((N, C, filter_h, filter_w, out_h, out_w)) for move_y in range(out_h): for move_x in range(out_w): for y in range(filter_h): for x in range(filter_w): col[:, :, y, x, move_y, move_x] = \ img[:, :, y + stride * move_y, x + stride * move_x] col = col.transpose(0, 4, 5, 1, 2, 3).reshape(N*out_h*out_w, -1) return col実行してみます。

(見やすくするためにデータ数1、チャンネル数1に絞ってます)data = np.random.rand(1, 1, 7, 7) * 100 // 1 print('========== input ==========\n', data) print('=====================') filter_h = 3 filter_w = 3 stride = 2 pad = 0 col = im2col(data, filter_h=filter_h, filter_w=filter_w, stride=stride, pad=pad) col2 = im2col_slow(data, filter_h=filter_h, filter_w=filter_w, stride=stride, pad=pad) print('========== col ==========\n', col) print('=====================') print('========== col2 ==========\n', col2) print('=====================')同様の結果を得られました。

========== input ========== [[[[30. 91. 11. 13. 52. 44. 98.] [99. 6. 35. 41. 97. 72. 79.] [ 5. 92. 15. 95. 72. 8. 10.] [68. 5. 86. 25. 69. 46. 70.] [95. 32. 98. 49. 51. 19. 46.] [32. 15. 39. 44. 76. 58. 49.] [43. 47. 95. 1. 1. 12. 21.]]]] ===================== ========== col ========== [[30. 91. 11. 99. 6. 35. 5. 92. 15.] [11. 13. 52. 35. 41. 97. 15. 95. 72.] [52. 44. 98. 97. 72. 79. 72. 8. 10.] [ 5. 92. 15. 68. 5. 86. 95. 32. 98.] [15. 95. 72. 86. 25. 69. 98. 49. 51.] [72. 8. 10. 69. 46. 70. 51. 19. 46.] [95. 32. 98. 32. 15. 39. 43. 47. 95.] [98. 49. 51. 39. 44. 76. 95. 1. 1.] [51. 19. 46. 76. 58. 49. 1. 12. 21.]] ===================== ========== col2 ========== [[30. 91. 11. 99. 6. 35. 5. 92. 15.] [11. 13. 52. 35. 41. 97. 15. 95. 72.] [52. 44. 98. 97. 72. 79. 72. 8. 10.] [ 5. 92. 15. 68. 5. 86. 95. 32. 98.] [15. 95. 72. 86. 25. 69. 98. 49. 51.] [72. 8. 10. 69. 46. 70. 51. 19. 46.] [95. 32. 98. 32. 15. 39. 43. 47. 95.] [98. 49. 51. 39. 44. 76. 95. 1. 1.] [51. 19. 46. 76. 58. 49. 1. 12. 21.]] =====================オリジナルとの比較

自分で実装してみたおかげで、オリジナルの実装は

上記の素朴版で行っているフィルター移動分の2重ループをしなくて済むよう効率化したものだと気づきました。

(ストライド幅刻みでスライスすることで、フィルタを移動させて取得する分を一気に取得・コピーしている)絵にしてみるとこんな感じになるかと思います。

素朴版の実装におけるimgからcolへのコピー

オリジナルim2colにおけるimgからcolへのコピー

ループ処理が効率化された結果、あのような実装になっているのだなぁ...

という感じで自分の理解は落ち着きました。

- 投稿日:2019-02-11T18:43:11+09:00

python 現在時刻を文字列として整形する。

すぐ忘れるやつ

現在時刻からタイムスタンプストリングを作成する。import datetime now = datetime.datetime.now() str_timestamp = now.strftime("%y/%m/%d_%H:%M:%S")ファイルの最終更新日を取得して文字列として成形する。import datetime myfile = r"test\test.txt" dt = datetime.datetime.fromtimestamp(os.stat(myfile).st_mtime) str_timestamp = dt.strftime('%Y/%m/%d_%H:%M:%S')こんな感じの文字列になる>>> '19/02/11-18:29:14'

- 投稿日:2019-02-11T18:12:23+09:00

Dockerを使って機械学習の環境を作ろうとした話

目次

- 目標

- どんな環境作るの?

- Dockerfileの準備

- イメージを作成してコンテナを起動して潜入してみる

- Volumeを指定して、ファイルを同期してみる

- docker-composeで更に楽に作ろう!

- まとめ

目標

- Dockerを実際に触って慣れる

- Dockerを使って環境構築してみる