- 投稿日:2019-04-05T19:22:07+09:00

【ゴリ押し】Unity2018.3から2018.2へPrefabを壊さず持って行く方法

Unity2018.3から2018.2へダウングレードする際に死んでいく数多くのPrefabたちを守るための

ゴリ押し技救済措置です。

↓のような方法を試してもうまくいかなかった最終手段として考えてもらえればと思います。

Unity2018.3から2018.2へのダウングレードで壊れたPrefabをなんとかする方法|公式ブログ|バーチャルキャスト[Virtual Cast]

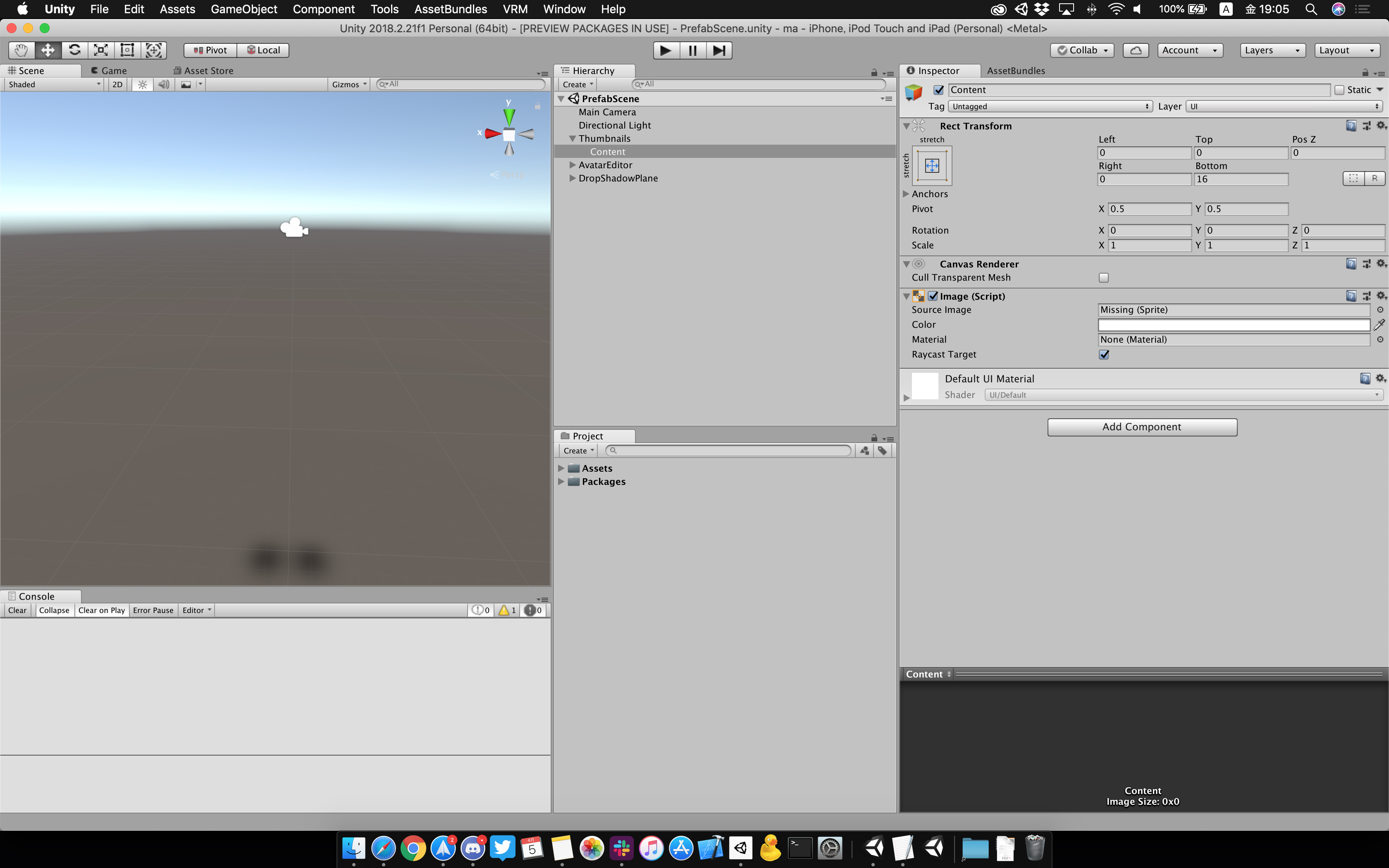

- 新規シーンを作成

- Prefabをすべてシーンに配置

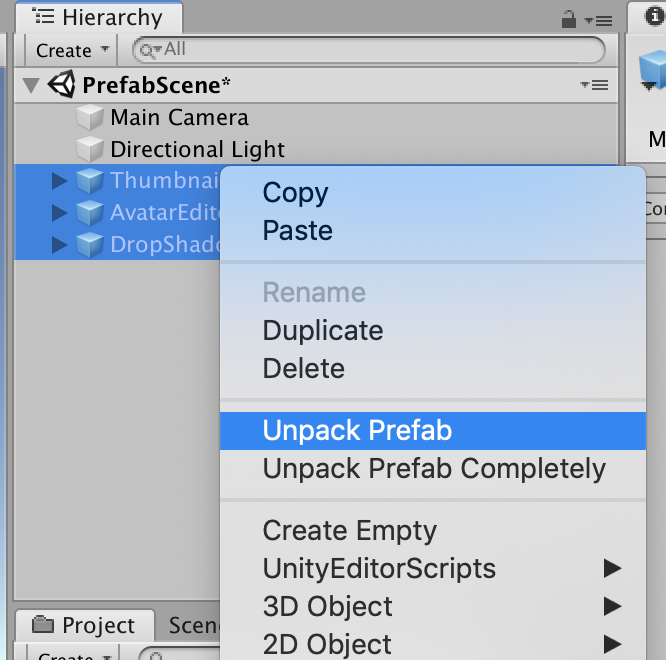

- 右クリック→Unpack PrefabでPrefabとの紐付けを解除

- シーンを保存

- そのままUnity2018.2へダウングレード。

- シーン内の元PrefabたちをそれぞれPrefab化する。

おわり。

コンポーネント類とのPrefabの参照はもちろん切れてしまいますが、Prefabを作り直すよりマシかなと思った次第です…。

Unity2018.3のNestedPrefabに苦しんでいる多くの方に届くことを祈っています。Best Wishes?

- 投稿日:2019-04-05T18:31:58+09:00

FirstPersonController.cs

The script of FPSController.

No editing.FirstPersonController.csusing System; using UnityEngine; using UnityStandardAssets.CrossPlatformInput; using UnityStandardAssets.Utility; using Random = UnityEngine.Random; namespace UnityStandardAssets.Characters.FirstPerson { [RequireComponent(typeof (CharacterController))] [RequireComponent(typeof (AudioSource))] public class FirstPersonController : MonoBehaviour { [SerializeField] private bool m_IsWalking; [SerializeField] private float m_WalkSpeed; [SerializeField] private float m_RunSpeed; [SerializeField] [Range(0f, 1f)] private float m_RunstepLenghten; [SerializeField] private float m_JumpSpeed; [SerializeField] private float m_StickToGroundForce; [SerializeField] private float m_GravityMultiplier; [SerializeField] private MouseLook m_MouseLook; [SerializeField] private bool m_UseFovKick; [SerializeField] private FOVKick m_FovKick = new FOVKick(); [SerializeField] private bool m_UseHeadBob; [SerializeField] private CurveControlledBob m_HeadBob = new CurveControlledBob(); [SerializeField] private LerpControlledBob m_JumpBob = new LerpControlledBob(); [SerializeField] private float m_StepInterval; [SerializeField] private AudioClip[] m_FootstepSounds; // an array of footstep sounds that will be randomly selected from. [SerializeField] private AudioClip m_JumpSound; // the sound played when character leaves the ground. [SerializeField] private AudioClip m_LandSound; // the sound played when character touches back on ground. private Camera m_Camera; private bool m_Jump; private float m_YRotation; private Vector2 m_Input; private Vector3 m_MoveDir = Vector3.zero; private CharacterController m_CharacterController; private CollisionFlags m_CollisionFlags; private bool m_PreviouslyGrounded; private Vector3 m_OriginalCameraPosition; private float m_StepCycle; private float m_NextStep; private bool m_Jumping; private AudioSource m_AudioSource; public bool AllowRotate; // Use this for initialization private void Start() { m_CharacterController = GetComponent<CharacterController>(); m_Camera = Camera.main; m_OriginalCameraPosition = m_Camera.transform.localPosition; m_FovKick.Setup(m_Camera); m_HeadBob.Setup(m_Camera, m_StepInterval); m_StepCycle = 0f; m_NextStep = m_StepCycle/2f; m_Jumping = false; m_AudioSource = GetComponent<AudioSource>(); m_MouseLook.Init(transform , m_Camera.transform); } // Update is called once per frame private void Update() { if (AllowRotate) { RotateView(); } // the jump state needs to read here to make sure it is not missed if (!m_Jump) { m_Jump = CrossPlatformInputManager.GetButtonDown("Jump"); } if (!m_PreviouslyGrounded && m_CharacterController.isGrounded) { StartCoroutine(m_JumpBob.DoBobCycle()); PlayLandingSound(); m_MoveDir.y = 0f; m_Jumping = false; } if (!m_CharacterController.isGrounded && !m_Jumping && m_PreviouslyGrounded) { m_MoveDir.y = 0f; } m_PreviouslyGrounded = m_CharacterController.isGrounded; } private void PlayLandingSound() { m_AudioSource.clip = m_LandSound; m_AudioSource.Play(); m_NextStep = m_StepCycle + .5f; } private void FixedUpdate() { float speed; GetInput(out speed); // always move along the camera forward as it is the direction that it being aimed at Vector3 desiredMove = transform.forward*m_Input.y + transform.right*m_Input.x; // get a normal for the surface that is being touched to move along it RaycastHit hitInfo; Physics.SphereCast(transform.position, m_CharacterController.radius, Vector3.down, out hitInfo, m_CharacterController.height/2f, Physics.AllLayers, QueryTriggerInteraction.Ignore); desiredMove = Vector3.ProjectOnPlane(desiredMove, hitInfo.normal).normalized; m_MoveDir.x = desiredMove.x*speed; m_MoveDir.z = desiredMove.z*speed; if (m_CharacterController.isGrounded) { m_MoveDir.y = -m_StickToGroundForce; if (m_Jump) { m_MoveDir.y = m_JumpSpeed; PlayJumpSound(); m_Jump = false; m_Jumping = true; } } else { m_MoveDir += Physics.gravity*m_GravityMultiplier*Time.fixedDeltaTime; } m_CollisionFlags = m_CharacterController.Move(m_MoveDir*Time.fixedDeltaTime); ProgressStepCycle(speed); UpdateCameraPosition(speed); m_MouseLook.UpdateCursorLock(); } private void PlayJumpSound() { m_AudioSource.clip = m_JumpSound; m_AudioSource.Play(); } private void ProgressStepCycle(float speed) { if (m_CharacterController.velocity.sqrMagnitude > 0 && (m_Input.x != 0 || m_Input.y != 0)) { m_StepCycle += (m_CharacterController.velocity.magnitude + (speed*(m_IsWalking ? 1f : m_RunstepLenghten)))* Time.fixedDeltaTime; } if (!(m_StepCycle > m_NextStep)) { return; } m_NextStep = m_StepCycle + m_StepInterval; PlayFootStepAudio(); } private void PlayFootStepAudio() { if (!m_CharacterController.isGrounded) { return; } // pick & play a random footstep sound from the array, // excluding sound at index 0 int n = Random.Range(1, m_FootstepSounds.Length); m_AudioSource.clip = m_FootstepSounds[n]; m_AudioSource.PlayOneShot(m_AudioSource.clip); // move picked sound to index 0 so it's not picked next time m_FootstepSounds[n] = m_FootstepSounds[0]; m_FootstepSounds[0] = m_AudioSource.clip; } private void UpdateCameraPosition(float speed) { Vector3 newCameraPosition; if (!m_UseHeadBob) { return; } if (m_CharacterController.velocity.magnitude > 0 && m_CharacterController.isGrounded) { m_Camera.transform.localPosition = m_HeadBob.DoHeadBob(m_CharacterController.velocity.magnitude + (speed*(m_IsWalking ? 1f : m_RunstepLenghten))); newCameraPosition = m_Camera.transform.localPosition; newCameraPosition.y = m_Camera.transform.localPosition.y - m_JumpBob.Offset(); } else { newCameraPosition = m_Camera.transform.localPosition; newCameraPosition.y = m_OriginalCameraPosition.y - m_JumpBob.Offset(); } m_Camera.transform.localPosition = newCameraPosition; } private void GetInput(out float speed) { // Read input float horizontal = CrossPlatformInputManager.GetAxis("Horizontal"); float vertical = CrossPlatformInputManager.GetAxis("Vertical"); bool waswalking = m_IsWalking; #if !MOBILE_INPUT // On standalone builds, walk/run speed is modified by a key press. // keep track of whether or not the character is walking or running m_IsWalking = !Input.GetKey(KeyCode.LeftShift); #endif // set the desired speed to be walking or running speed = m_IsWalking ? m_WalkSpeed : m_RunSpeed; m_Input = new Vector2(horizontal, vertical); // normalize input if it exceeds 1 in combined length: if (m_Input.sqrMagnitude > 1) { m_Input.Normalize(); } // handle speed change to give an fov kick // only if the player is going to a run, is running and the fovkick is to be used if (m_IsWalking != waswalking && m_UseFovKick && m_CharacterController.velocity.sqrMagnitude > 0) { StopAllCoroutines(); StartCoroutine(!m_IsWalking ? m_FovKick.FOVKickUp() : m_FovKick.FOVKickDown()); } } private void RotateView() { m_MouseLook.LookRotation (transform, m_Camera.transform); } private void OnControllerColliderHit(ControllerColliderHit hit) { Rigidbody body = hit.collider.attachedRigidbody; //dont move the rigidbody if the character is on top of it if (m_CollisionFlags == CollisionFlags.Below) { return; } if (body == null || body.isKinematic) { return; } body.AddForceAtPosition(m_CharacterController.velocity*0.1f, hit.point, ForceMode.Impulse); } } }

- 投稿日:2019-04-05T16:31:20+09:00

Unityで関節PositionのみでAnimatorを動かす

Unityで関節PositionのみでAnimatorを動かす

をダウンロード、Unityへ入れる

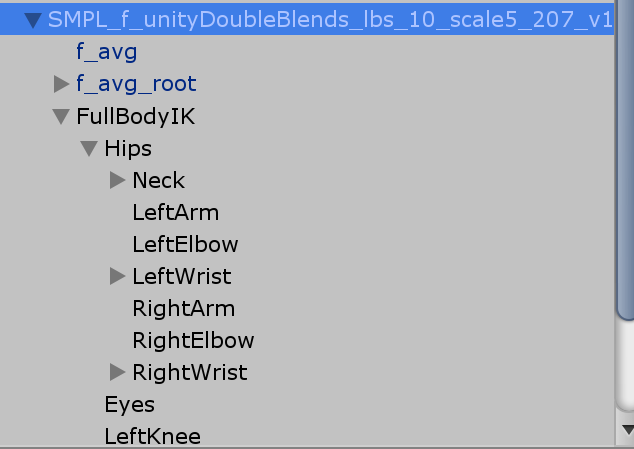

SAFullBodyIK-master/Scripts/FullBodyIKBehaviourを使いたいHumanoidに張り付け

これでHumanoidについているFullBody以下を動かせばHumanoidが動く。

EffectorのElbowやKneeについているPosをチェックするとKneeやElbowも動かせる。

以下、Targetヒューマノイドの動きをPositionベースでまねるスクリプト。

using UnityEngine; public class AnimationFromPositionWithFbik : MonoBehaviour { public Animator target; Animator animator; // Use this for initialization void Start () { animator = GetComponent<Animator>(); } // Update is called once per frame void Update () { this.transform.position = ChangeP(target.transform.position); GameObject fullBIK = this.transform.Find("FullBodyIK").gameObject; foreach(IKset ik in IKsets) { fullBIK.transform.Find(ik.getI()).position = ChangeP(target.GetBoneTransform(ik.getB()).position); } } Vector3 ChangeP(Vector3 v) { return new Vector3(v.x -0.5f, v.y, v.z); } struct IKset { HumanBodyBones bone; string IKbone; public string getI(){ return IKbone; } public HumanBodyBones getB() { return bone; } public IKset(HumanBodyBones b, string ik) { bone = b; IKbone = ik; } } IKset[] IKsets = new IKset[] { new IKset(HumanBodyBones.Hips,"Hips"), new IKset(HumanBodyBones.RightLowerLeg,"RightKnee"), new IKset(HumanBodyBones.RightFoot,"RightFoot"), new IKset(HumanBodyBones.LeftLowerLeg,"LeftKnee"), new IKset(HumanBodyBones.LeftFoot,"LeftFoot"), new IKset(HumanBodyBones.Neck,"Hips/Neck"), new IKset(HumanBodyBones.Head,"Hips/Neck/Head"), new IKset(HumanBodyBones.LeftShoulder,"Hips/LeftArm"), new IKset(HumanBodyBones.LeftLowerArm,"Hips/LeftElbow"), new IKset(HumanBodyBones.LeftHand,"Hips/LeftWrist"), new IKset(HumanBodyBones.RightShoulder,"Hips/RightArm"), new IKset(HumanBodyBones.RightLowerArm,"Hips/RightElbow"), new IKset(HumanBodyBones.RightHand,"Hips/RightWrist"), }; }似た動きはするが精度はまちまち

参考

http://onoty3d.hatenablog.com/entry/2015/06/05/194010

https://qiita.com/keel/items/0d64167850566586d22a

- 投稿日:2019-04-05T15:06:46+09:00

VTuberなどに使われる主要なリップシンク方式の比較メモ

はじめに

(この記事はエンジニア以外の方でも分かるような内容になっています)

VTuberで使われる技術の一つにリップシンクというものがあります。発話に併せてアバターの口を人と同じように動かす技術のことです。

また、二次元寄りの表現をする場合には、本物の人と同じように滑らかに動かすよりも、緩急を付けてアニメ調の動きにした方が自然な場合もあります。

Live2Dでアニメ調のリップシンクを実現する『AniLipSync-live2d』の使い方 - Qiitaこのリップシンクを実現するにあたり、いくつかの方法が検討されています。この記事ではそれぞれの方式の長所短所を簡単にまとめたいと思います。紹介しているライブラリ等は全てUnity用のものになります。

画像認識による方法

映像から口の形を認識して反映させる方法です。iOSの「アニ文字」などがこの方式です。

参考: 速報:iPhone X「アニ文字」の使い方。サクサク顔認識、気軽に使えます - YouTube

長所

- 口の形を正確に認識できるため、リッチな表現がしやすい

短所

- 画像認識のためにカメラが必要となる

- アニメ調の表現には不向きな場合がある

ライブラリ等

- ARKitのFace Tracking (iOSのみ)

- 無料

- Dlib FaceLandmark Detector

- 有償 (OpenCVも必要)

- 学習データが商用NG(要出典)

- Single Face Tracker Plugin

- 有償

- 価格は高いが数少ない商用利用が可能な顔認識ライブラリ

音圧の大小による方法

音声の音量を口の大きさに反映させる方式です。喋っていない時は口が閉じていて、声を出すと音量に応じて口が開きます。シンプルな表現ですが、アニメ調の表現の場合、実はこのくらいで十分だったりします。

【初心者向け】UnityとLive2Dで拡張しやすいVTuber配信システムを作る方法 - Qiita同じ方式ですが、少し工夫した方式もあります。以下の例では音量のみからリップシンクをしていますが、いくつかの異なる口の動きになっていると思います。

[iOSでも動く] SALSAでバーチャルYouTuber向けのリップシンクを導入する方法 - Qiitaどうしているかというと、音量の範囲に応じて口の形を変更しています。例えば、

- 小さい音の時は「お」の口

- 中くらいの音の時は「え」の口

- 大きい音の時は「あ」の口

といった具合です。高度な音声認識技術を使わなくても、工夫次第でこのくらいまで自然な動きを作れるという良い例だと思います。

長所

- マイクだけあれば良いため、構成がシンプル

短所

- 他の方式と比べ、表現力が低い

- 周りの雑音などで口が動いてしまう場合がある

ライブラリ等

- 独自実装

- シンプルなのでそう難しくない

- SALSA With RandomEyes

- 有料

- 上記の音圧の範囲毎に口の形をマッピングしてくれるライブラリ

音声認識による口形素推定

音声認識によりどんな音を発しているのかを推定して口の形に反映させる方法です。日本では母音の「あ」「い」「う」「え」「お」の5つを認識する方法が多いです。画像認識の方法は「口がどの形をしているか」を認識しているのに対し、この方法は「どの音を発しているか」をまず認識し、次に「その音を発する口の形はどうか」という流れです。

よく使われるOVRLipSycnというライブラリでは、口形素(viseme)を15個まで認識できます(sil, PP, FF, TH, DD, kk, CH, SS, nn, RR, aa, E, ih, oh, and ou)。

引用元: Oculus Lipsync Guide長所

- マイクだけあれば良いため、構成がシンプル

- 音圧だけの方法と違い、表現力が豊か。

- 周囲の雑音などは声でないので認識されない

短所

- 機械学習などを使って推定している場合、一般的な話し声とかけ離れた音声を認識できないことがある

- 女性声優など極端に高い声の人の声は認識できないことが多いそうです

ライブラリ等

- Oculus Lipsync Guide

- 無料

- VR用アセットだが良く使われる

- Win, Mac, Androidに対応しているが、iOSでは動かない

- LipSync Pro

- 有料

- エディタ上でフェイシャルアニメーションを作成するアセット

- リアルタイムは不可

最後に

よく使われる方法としては上記の3つだと思います。(もし他にあれば @nkjzmまでご連絡いただけると嬉しいです)

読んでいただける分かる通り、それぞれの方法には一長一短があります。そのためアプリによっては複数の方法を切り替えられるようにしていることもあります。リップシンクを利用する場合は状況に併せて適した方式を検討されるのが良いかと思います。

- 投稿日:2019-04-05T00:51:15+09:00

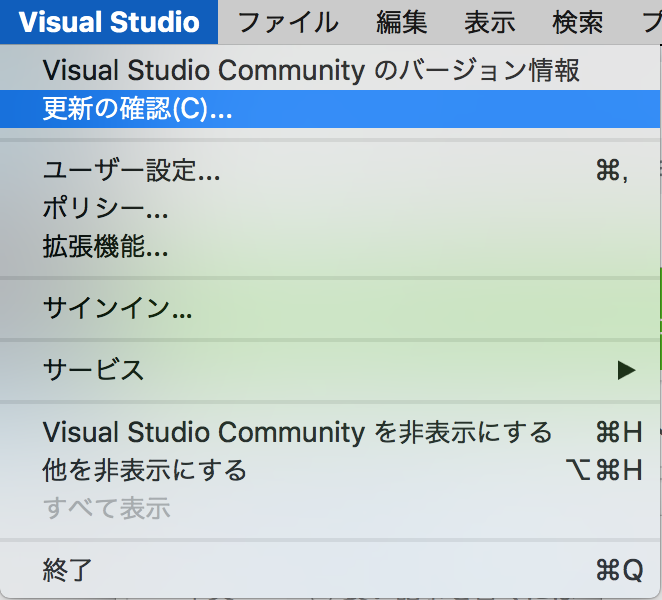

【Visual Studio2019】へアップデートする

Visual Studio 2019が本格リリースされました!

さっそくアップデートしようとしましたが、少し調べる必要があったのでやり方をまとめます。新規インストールはこちらから

https://visualstudio.microsoft.com/ja/vs/mac/環境

macOS High Sierra 10.13.6

アップデート手順

公式

https://docs.microsoft.com/en-us/visualstudio/mac/update?view=vsmac-2019

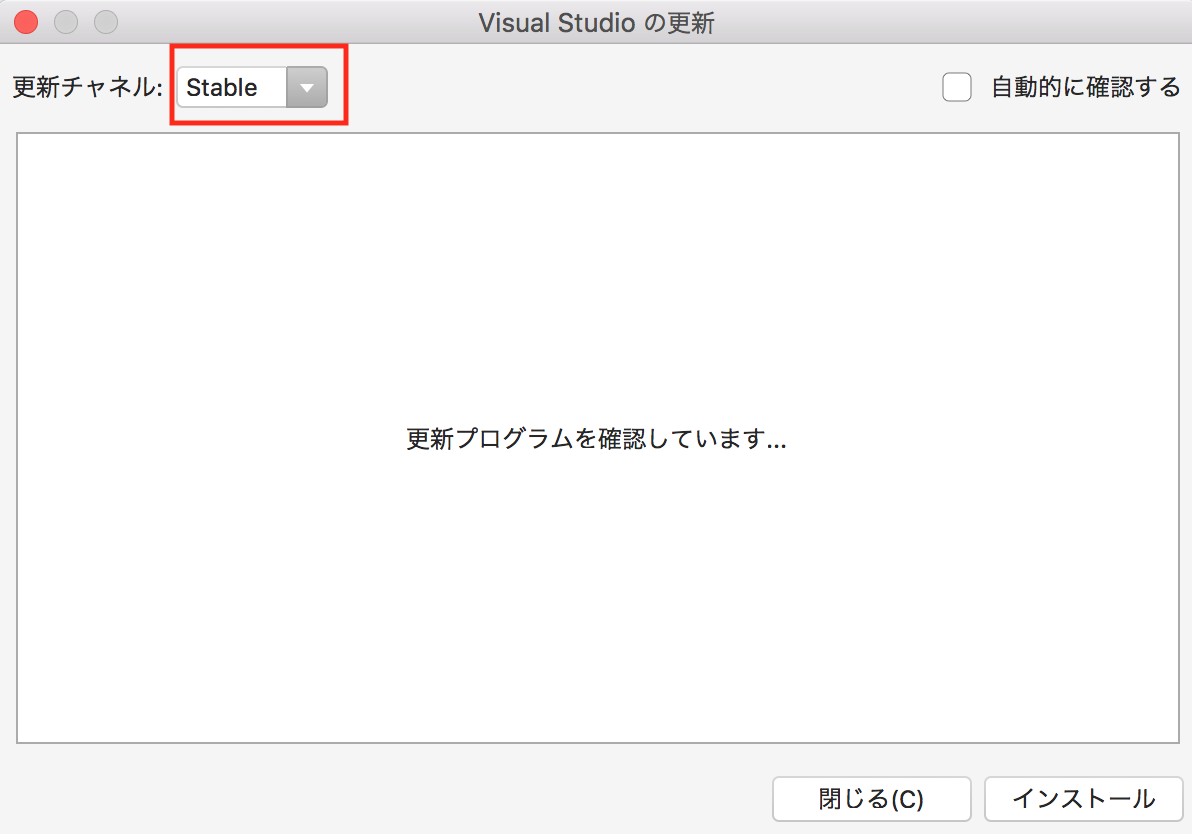

公式読むのめんどい人向け

更新チャンネルを「Stable」にして更新プログラムを確認しましょう。

あとは自動で進むと思います。

おわり