- 投稿日:2019-02-18T23:44:32+09:00

PythonでGoogle Places API使ってデータ取得してみた

概要

Pythonを使用してGoogle Places APIのデータを取得した忘備録です。

APIでデータ取り出すだけならJSとかで問題ないんですが、その後データをこねこねしたかったのでPythonで取得しました。(結局使わなかったけど)公式ドキュメント等

Google Developers Places API (Googleドキュメント)

google-maps-services-python (PythonクライアントのGit)

Python Client for Google Maps Services (Pythonライブラリドキュメント)1. Google Place APIを使えるようにする

GCPのプロジェクト作成~API有効までの手順は以下のブログを参考にさせていただきました。

Google Places APIで会社付近の「お食事処」を取得してみるGCPはAPIの無料枠があるのでそれを使用します。(クレジットカードの登録が必要です)

また、APIキーのアクセス制限では、「リクエストを受け入れるサーバーIPアドレス」に自身のIPアドレスを設定するなどしておくと安全です。

キー盗まれてXX万円請求くるとか話聞くので・・・。2.APIリクエストを送ってデータ取得

ファイルの内容は以下です。

「東京渋谷駅」で位置情報を検索して、その位置から半径200m以内のレストランの情報を取得します。import googlemap import pprint # list型やdict型を見やすくprintするライブラリ key = 'Your API' # 上記で作成したAPIキーを入れる client = googlemaps.Client(key) #インスタンス作成 geocode_result = client.geocode('東京都渋谷駅') # 位置情報を検索 loc = geocode_result[0]['geometry']['location'] # 軽度・緯度の情報のみ取り出す place_result = client.places_nearby(location=loc, radius=200, type='food') #半径200m以内のレストランの情報を取得 pprint.pprint(place_result)上記ファイルを実行するとコンソールにレストランの情報一覧が表示されます。

おしまい!

最後に

レビューデータを大量に欲しかったんですが、ドキュメントみると

reviews[] a JSON array of up to five reviews.

とあり、取得制限があったので諦めました。笑

Twitter APIでも取得制限で苦しめられた覚えがあります。。。

何かいい方法があったら教えてください。

また、記事に間違いや不明な点があれば遠慮なくご指摘ください。

- 投稿日:2019-02-18T23:22:36+09:00

Scikit-learn でロジスティック回帰(確率予測編)

はじめに

ロジスティック回帰は、

- データを複数のクラスに分類する

- 事象が発生する確率を予測する

ために利用されるモデルです。

この記事では、Scikit-learnライブラリを使い、ロジスティック回帰により確率を予測する方法を備忘録として書いておきます。Scikit-learn について

Scikit-learnは、Pythonの機械学習ライブラリの一つです。

ロジスティック回帰について

ロジスティック回帰は、確率(例:機器の故障率)を予測するためのアルゴリズムです。機械学習系の文献では、分類のためのアルゴリズムとして紹介されていることが多いロジスティック回帰ですが、予測した確率(スコア)をもとにクラス分類を行う(例:機器を故障するクラス or 故障しないクラス に分類する)ものであるため、当然確率そのものを予測するためにも利用できます。

ロジスティック回帰では、対数オッズ比を説明変数 $x_i$ の線形和で表現します。予測したいこと(正事象)の確率を $p$ としたとき、オッズ比は $p/(1−p)$ と書くことができ、正事象の起こりやすさを表します。オッズ比の対数をとったものが、対数オッズです。

\log(\frac{p}{1−p}) = w_0x_0 + w_1x_1 + \cdots + w_mx_m = \sum_{i=0}^m w_ix_iここで、重み $w_0 $は $x_0=1$ として切片を表します。ロジスティック回帰は、対数オッズ比と複数の説明変数の関係を表すモデルの重み $w_i$ を学習することが目的です。

ただ、ロジスティック回帰を利用するときに関心があるのは、説明変数の値を与えたときの正事象の確率 $p$ です。そこで、上式を左辺が $p$ になるように変形すると、

p=\frac{1}{1+\exp(−\sum_{i=0}^m w_ix_i)}となります。モデルの重み $w_i$ を学習後、この式を利用して説明変数の値が与えられたときの正事象の確率を求めることができます。

ロジスティック回帰モデル

scikit-learnでロジスティック回帰をするには、linear_modelのLogisticRegressionモデル(公式ドキュメント:https://scikit-learn.org/stable/modules/generated/sklearn.linear_model.LogisticRegression.html )を使います。主に利用するメソッドは以下の通りです。

- fitメソッド:ロジスティック回帰モデルの重みを学習

- predict_probaメソッド:説明変数の値から各クラスに属する確率を予測

ここでは、sklearn.datasets ライブラリの make_classification メソッドで生成したデータに対して確率を予測します。以下のコードでは、200,000サンプルのデータを生成しており、説明変数(特徴量)の数は20、目的変数は0か1のクラスで、クラス0とクラス1のデータ数の比率はおよそ1:1です。

from sklearn.datasets import make_classification X, Y = make_classification(n_samples=200000, n_features=20, n_informative=2, n_redundant=2)以降では、説明変数Xを利用してロジスティック回帰モデルを構築し、目的変数が1となる確率を予測します。

ロジスティック回帰モデルの構築

ロジスティック回帰モデルのインスタンスを作成し、fitメソッドで説明変数の重みを学習することで、ロジスティック回帰モデルを構築します。ここでは、scikit-learnライブラリのmodel_selection.train_test_splitメソッドで、データをモデル構築用データ(学習データ)と予測精度検証用データ(検証データ)に分割し、学習データをfitメソッドの引数として与え、ロジスティック回帰モデルを構築しています。

from sklearn.model_selection import train_test_split from sklearn.linear_model import LogisticRegression X_train, X_test, Y_train, Y_test = train_test_split(X, Y, test_size=0.5, random_state=0) # 50%のデータを学習データに、50%を検証データにする lr = LogisticRegression() # ロジスティック回帰モデルのインスタンスを作成 lr.fit(X_train, Y_train) # ロジスティック回帰モデルの重みを学習ロジスティック回帰モデルのインスタンスを生成する際、モデルの重みを調整する正則化などの設定をするハイパーパラメータの設定ができます。詳細は公式ドキュメント、もしくは Scikit-learn でロジスティック回帰(クラス分類編) をご覧ください。

学習により得られた、ロジスティック回帰モデルの切片 $w_0$ はintercept_属性に、説明変数の係数 $w_1, \cdots, w_{20}$ はcoef_属性に格納されます。

print("coefficient = ", lr.coef_) print("intercept = ", lr.intercept_) coefficient = [[ 1.07367390e-03 5.17036366e-01 5.21447708e-03 -9.98281654e-03 3.44933503e-01 2.66695180e+00 -8.91173651e-03 2.27093901e-02 5.33371028e-03 -1.55647553e-02 -1.26011741e-02 -1.06324472e-03 3.09072395e+00 -4.44766398e-03 7.88774312e-03 2.99896065e-02 -1.35581106e-02 -1.96393314e-02 2.37722077e-03 2.48242512e-02]] intercept = [-0.89110432]このモデルに対し、検証データの説明変数の値を引数としてpredict_probaメソッドを実行すると、それぞれの検証データの目的変数(クラス)が0である確率と、1である確率が予測できます。出力結果の1列目が目的変数が0である確率、2列目が目的変数が1である確率です。

probs = lr.predict_proba(X_test) print(probs) [[7.17584367e-02 9.28241563e-01] [9.99301416e-01 6.98583960e-04] [1.80200179e-03 9.98197998e-01] ... [3.34485484e-02 9.66551452e-01] [6.32885474e-02 9.36711453e-01] [4.45884313e-04 9.99554116e-01]]ロジスティック回帰モデルの性能評価

確率予測の性能評価には、主に以下のような指標が用いられます。

- キャリブレーションプロット

- ロジスティック損失(logistic loss)

- brier score(ブライヤースコア)

キャリブレーションプロットは、予測した確率が実際の確率(割合)に一致するかを確認するものであり、ロジスティック損失やbrier scoreは、モデル間の予測精度の比較に用いることが多いです。

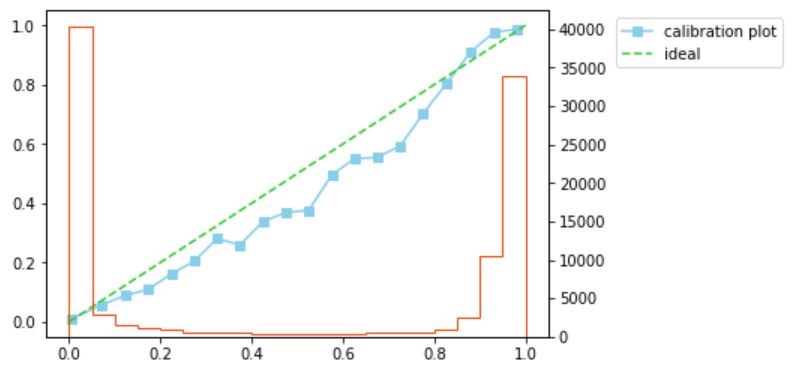

キャリブレーションプロットは、横軸をモデルで予測した目的変数が1である確率(スコア)を複数の区間(ビン)に区切ったもの、縦軸を各ビンに該当するデータのうち目的変数が実際に1であるデータの割合をとったグラフです。スコアと、実際に目的変数が1のデータの割合(分布)が一致するかを確認するために利用します。スコアと実際の割合が一致するとき、キャリブレーションプロットは45度線に乗るため、キャリブレーションプロットが45度線に近いほど、モデルの予測性能が高いといえます。

たとえば、以下のようなコードでキャリブレーションプロットを作成できます。ここでは、検証データに対して目的変数が1である確率を予測し、sklearn.calibrationライブラリのcalibration_curveメソッドを利用してキャリプレーションプロットを作成しています。今回の検証データで作成したキャリブレーションプロットは、45度線より若干下ぶれていますが、おおむね45度線に近いかな、という印象です。

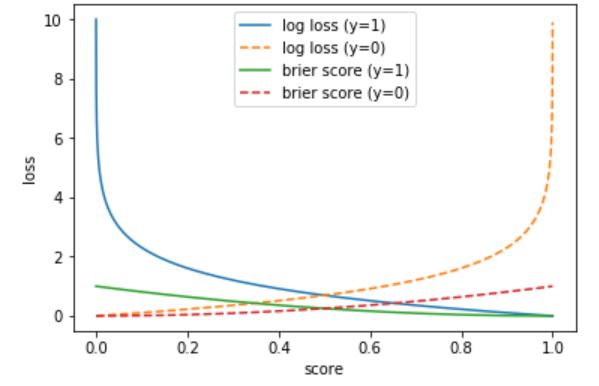

import matplotlib.pyplot as plt from sklearn.calibration import calibration_curve prob = lr.predict_proba(X_test)[:, 1] # 目的変数が1である確率を予測 prob_true, prob_pred = calibration_curve(y_true=Y_test, y_prob=prob, n_bins=20) fig, ax1 = plt.subplots() ax1.plot(prob_pred, prob_true, marker='s', label='calibration plot', color='skyblue') # キャリプレーションプロットを作成 ax1.plot([0, 1], [0, 1], linestyle='--', label='ideal', color='limegreen') # 45度線をプロット ax1.legend(bbox_to_anchor=(1.12, 1), loc='upper left') ax2 = ax1.twinx() # 2軸を追加 ax2.hist(prob, bins=20, histtype='step', color='orangered') # スコアのヒストグラムも併せてプロット plt.show()ロジスティック損失は、brier socreと同様にスコアと実際の目的変数の値の誤差を表した指標で、誤差が大きいほど損失が指数関数的に大きくなる特徴があります。式で書くと、

logistic \ \ loss = -\frac{1}{n}\sum_{i=1}^n \{y_i \log p_i + (1-y_i)\log(1-p_i)\}です。$p_i$ と $y_i$ の定義は、brier scoreの定義と同様です。

ちなみに、ロジスティック回帰は、ロジスティック損失が最小となるようにモデルの重みを学習しています。以下のコードでは、sklearn.metrics ライブラリの log_loss を利用して、検証データに対するロジスティック損失を算出しています。

from sklearn.metrics import log_loss print('logistic loss = ', log_loss(y_true=Y_test, y_pred=prob)) logistic loss = 0.13207794568463985brier socre(ブライヤースコア)は、確率予測の正確さを測るための指標のひとつで、スコアと実際の目的変数の値の平均二乗誤差で定義されます。式で書くと、

brier \ \ score = \frac{1}{n} \sum_{i=1}^n (p_i - y_i)です。ここで、$p_i$ は $i$ 番目のデータの目的変数が1であると予測した確率(スコア)、$y_i$ は $i$ 番目のデータの実際の目的変数の値です。

以下のコードでは、sklearn.metrics ライブラリの brier_score_loss を利用して、検証データに対するbrier score を算出しています。

from sklearn.metrics import brier_score_loss print('brier score = ', brier_score_loss(y_true=Y_test, y_prob=prob)) brier score = 0.031796375907874444参考までに、スコアに対してロジスティック損失とbrier scoreがどのような値をとるかを見てみます。下図では、目的変数の実績値が1のときのロジスティック損失(青実線)とbrier score(緑実線)、目的変数の実績値が0のときのロジスティック損失(黄点線)とbrier score(赤点線)をプロットしています。この図を見ると、スコアと実績値の差が大きくなったときの値は、ロジスティック損失のほうが大きくなる傾向があることがわかります。

おわりに

この記事では、scikit-learnライブラリでロジスティック回帰モデルを構築し、確率予測の性能評価をする方法について簡単に触れました。

参考

- [第2版]Python機械学習プログラミング 達人データサイエンティストによる理論と実装(https://www.amazon.co.jp/dp/B07BF5QZ41/ref=dp-kindle-redirect?_encoding=UTF8&btkr=1 )

- 投稿日:2019-02-18T23:22:00+09:00

python入門(8)

if文

if文は条件分岐を行うときに使います.条件式には比較演算子や論理演算子を使用します.

div.pya = 3 print(a, 'は', end ='') if a % 2 ==0: print('偶数') else: print('奇数')実行結果3 は奇数if文では条件を書いた後に「:」をつけます.また,pythonではインデントによって処理の塊であるブロックを指定します.インデントでは,空白半角4文字分が推奨されています.

elif

elifとは他言語でいうelse ifと同じものです.また,if文では最初にtrueだった条件を実行しそれ以降は実行しません.

div2.pya = 78 print(a, '点の人は', end = '') if a >= 90: print('秀です.') elif a >= 80: print('優です.') elif a >= 70: print('良です.') elif a >= 60: print('可です.') else: print('不可です.また来年会いましょう.')実行結果78 点の人は良です.if文のネスト

if文などの制御文の中にさらに制御文を入れることをネストと言います.

div3.pyyear = 2000 print(year, '年は', end = '') if year % 4 == 0: if (year % 100 != 0) or (year % 400 == 0): print('閏年です.') else: print('閏年ではありません.')実行結果2000 年は閏年です.最後に

if文は他言語との違いが少ないので基本は簡単にできると思います.自分のペースで学習しましょう.

- 投稿日:2019-02-18T22:16:48+09:00

Django Webアプリ作成(4) モデル作成

環境

OS : macOS Mojave

Anaconda : python3.6.7

Django==2.1.5今回の目標

アプリの中身の最重要部分"モデル"の作成

モデルとは

簡単に言うと、"データベースのデータの集合"

データベースにデータを格納しておいて状況に応じて取り出すイメージ必要なデータは...

今回のアプリは、ブログということで当然タイトルと内容(テキスト)は必要でしょう。

その他、筆者と作成日時と更新日時を要素(データ)としよう!models.py

models.py内にPostクラスを作成

blog/models.pyfrom django.db import models from django.utils import timezone class Post(models.Model): author = models.ForeignKey('auth.User', on_delete=models.CASCADE) title = models.CharField(max_length=200) text = models.TextField() created_date = models.DateTimeField( default=timezone.now) published_date = models.DateTimeField( blank=True, null=True) def publish(self): self.published_date = timezone.now() self.save() def __str__(self): return self.titleデータベースの作成と追加

データベースの作成

Terminalpython manage.py makemigrationsデータベースの追加

Terminalpython manage.py migrate管理者ページ(Django admin)の作成

blog/admin.pyに作ったモデルクラスを登録

blog/admin.pyfrom django.contrib import admin from .models import Post # Register your models here. admin.site.register(Post)スーパーユーザーの作成

管理者サイトにログインできるスパーユーザーを作成する。

Terminalpython manage.py createsuperuser管理者ページにログインして記事を投稿

開発サーバを起動

Terminalpython manage.py runserverブラウザでアクセス

ブラウザhttp://127.0.0.1:8000/admin先程登録したユーザー、パスワードでログイン

無事ログインできましたか?

3つほど記事を投稿してみましょう!次回はWebサイトのページを作っていきます!

- 投稿日:2019-02-18T22:11:12+09:00

プログラミングでわかりやすい変数名の決め方

目的

「読みやすいコードを書く」

読みやすいコードを書く上で、わかりやすい変数を命名することは非常に重要。

自分が日頃から意識している命名ルールをまとめる。*na90ya様にコメントでご指摘いただいた点を改善しております。ありがとうございます!

ルール一覧

- 1. df, tmp, data, a, 等の名前は使わない!

- 2. 何を指している変数かすぐわかる名前をつける

- 3. 一つの変数に一つの意味

- 4. 略語を使うならば、意味を残しておく

1. df, tmp, data, a, 等の言葉は使わない!

読みやすいコードを書く目的は、コードレビューやコードの改善、機能の追加等が考えられるが、その時に全ての変数がa1, a2, a3...とかだったら、なんのことやらわからない。

だから、変数名を決める時はめんどくさがらずに意味を持った名前をつける!

*例外

(例)2つの変数の中身を入れ替えるコードright = 0 left = 1 if right < left: tmp = right right = left left = tmp print(right, left)このような場合、tmpという名前で全く問題ない。

tmpはデータの一時保管場所の役割を果たしており、「この変数は他に役割がない」ことを示している。

変数の寿命(変数が3行しか登場しない)が十分短い時はこのように使用してもいい。*pythonでは下記のように簡単に記載できるが、tmpの例として上記をあげている。

right, left = left, right2. 何を指しているすぐ変数かわかる名前をつける

その変数名を見て何のデータかすぐにわかる名前をつける

例)new_dataの意味は?

1. 新たに生成したデータ

2. 何かしらフィルタをかけた後のデータnewの意味は幅広く一見何を表しているかわからない。

もしも、上記の意味のデータならば

- created_data

- selected_data, filtered_data

等の単語を使うべきだろう。

その言葉を見ただけで、なんのデータかわかるようにするといい。*オススメのサイト

codic: プログラマーのためのネーミング辞書

日本語を記入すると、それに対応する短くわかりやすい英単語を返してくれるサイト。

使い方はこちら3. 一つの変数に一つの意味

途中で変数の意味を変える or 一つの意味のデータなのに複数変数名がある はNG!

途中で変数の意味を変える

これは当たり前だが、途中で変数の内容が変わったら読みにくい。

一度変数を決めたら、その後は変数を変更しないようにする!一つの意味のデータなのに複数変数名がある

user_ID, account_ID, ID ...

別々のIDだから名前を変えていると推測するため、一つのデータには一つの変数名のみを使用する。4. 略語を使うならば、意味を残しておく

よく使う単語は略したくなる。

filter -> _f

select -> _sel

columns -> colこうして並べてみると一目瞭然だが、何も知らない人が見たらわからないかもしれない。

だから、できるだけつけるのはやめたほうがいい。

もしつけるのならば、チームで共有する。最初に略語一覧を書く。等を意識する。まとめ

自分以外の人が読む時のことを常に意識しながらプログラミングすることは非常に重要なので、ぜひ意識して実践して欲しい。

名前をつける上で非常に参考になるサイト・書籍

- 投稿日:2019-02-18T22:07:49+09:00

AtomにおけるPython開発環境構築

はじめに

AtomテキストエディタにPython開発環境を最小限の拡張パッケージで構築します。各節の名称がパッケージ名になっているので,その名前でパッケージを検索してインストールしてください。Pythonの実行環境は、Minicondaを使い、

C:\Users\daizu\Miniconda3以下にインストールされていることを想定します。適宜読み替えてください。platformio-ide-terminal

Atom内でターミナルを実行します。

Settings

- Auto Run Command: C:\Users\daizu\Miniconda3\Scripts\activate.bat base

- Shell Override: C:\Windows\System32\cmd.exe

(後から、仮想環境

baseはデフォルトで使う別の仮想環境名にしても構いません。)MagicPython

Python言語のパッケージとしてMagicPythonを使います.コアパッケージのlanguage-pythonはdisableにします.

atom-ide-ui, ide-python

AtomでPython開発をするときの必須パッケージです。まずは、Minicondaの仮想環境

atomを作成します。Atomエディタで [Ctrl]-` を入力し、platformio-ide-terminalのコマンドプロンプトを開き、以下を実行します。(base) > conda create -n atom python (base) > activate atom (atom) > pip install python-language-server[all] pyls-isort pyls-mypyAtomが

atom環境を認識できるように、パスを追加します。AtomのFile->Init Script...でinit.coffeeを開き、process.env.PATH = [ "C:\\Users\\daizu\\Miniconda3\\envs\\atom", "C:\\Users\\daizu\\Miniconda3\\envs\\atom\\Library\\bin", "C:\\Users\\daizu\\Miniconda3\\envs\\atom\\Scripts", process.env.PATH ].join(";")を追加します。(後述するように、続けて別の仮想環境をパスに追加することもできます。)これで、pycodestyle, pyflakes, isort, mypyなどがAtom上で使えるようになります。

Hydrogen

Jupyterを使って,Atom上でPythonコードの実行ができます.インタラクティブな実行が可能なので,非常に重宝します.Hydrogenを使う仮想環境下(仮に

daizuとします)で,以下を実行します。(base) > conda create -n daizu python (base) > activate daizu (daizu) > conda install jupyter (daizu) > python -m ipykernel install --user --name daizu

init.coffeeを開き、以下のように変更します。process.env.PATH = [ "C:\\Users\\daizu\\Miniconda3\\envs\\atom", "C:\\Users\\daizu\\Miniconda3\\envs\\atom\\Library\\bin", "C:\\Users\\daizu\\Miniconda3\\envs\\atom\\Scripts", "C:\\Users\\daizu\\Miniconda3\\envs\\daizu", "C:\\Users\\daizu\\Miniconda3\\envs\\daizu\\Library\\bin", "C:\\Users\\daizu\\Miniconda3\\envs\\daizu\\Scripts", process.env.PATH ].join(";")以上で、開発環境が整いました。

- 投稿日:2019-02-18T22:00:12+09:00

PythonでSharePointの特定サイトの特定リストの特定レコードのURLを取得する方法

本記事は

この記事の番外編になります。

PowerApps でセンサーデータの値を取得してみた!(ソースもあるよ!)まず最初に・・・

SharePointのレコードデータを取得するためにはどうするのか?

このようなURL構造にして

メソッドによって処理を変えます。

- Get:レコードのデータを取得

- Patch:レコードを更新

- Delete:レコードを削除

つまりは・・・

以下の手順を踏んでいけば、このURLパスが完成することになります。

- サイト名を元に検索して、サイトIDを取得する

- 取得したサイトIDからリスト名を元に検索してリストIDを取得する

- 取得したサイトID及びリストIDから検索するレコードの特定カラムの文字列を検索してレコードIDを取得する

検索に必要なデータは予め変数として格納しておきます。

では取得していきましょう。

検索用の変数

以下のようにします。

変数名 用途 SPS_SiteName 検索するサイト名称 SPS_ListName 検索するリスト名称 SPS_SearchColumn 検索対象のリスト列名 SPS_SearchRecord 検索文言 サイトIDを取得する

GetSPSSiteID# サイトIDを取得するためのURLを生成する。 SiteGet_URL = 'https://graph.microsoft.com/v1.0/sites?search=' \ + SPS_SiteName # Microsoft Graphを実行し、その結果をres1に格納する。 res1 = requests.get( SiteGet_URL, headers=headers ) # requrest処理をクローズする res1.close # res1をjsonファイルに整形 res1json = res1.json() # 結果からSiteIDを取得する。 SiteID = res1json['value'][0]['id']res1jsonの取得結果

res1json{ "@odata.context": "https://graph.microsoft.com/v1.0/$metadata#sites", "value": [ { "createdDateTime": "2018-06-08T01:54:26Z", "id": "xxxxxxxx.sharepoint.com,xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx,xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx", "lastModifiedDateTime": "2018-05-23T19:38:15Z", "name": "testsite", "webUrl": "https://xxxxxxxx.sharepoint.com/sites/zzzzzzzzzzzzzzzzzzzz", "displayName": "テストサイト", "root": {}, "siteCollection": { "hostname": "xxxxxxxx.sharepoint.com" } } ] }ここで詰まったところ

['value']['id']とすれば値が取得できると思っていました。

ところが、実際に投げたところ、こういうエラーが発生しました。TypeError: string indices must be integers, not str調べたところ、リストのインデックスは数値型じゃないとだめとのことです。

というわけで、値取得の方法を以下のように書き換えます。SiteID = res1json['value'][0]['id']今回、取得したjsonは1件しかない想定ですので

リストのインデックス番号「0」を付与することで

確実にパラメタを取得することができるようになります。リストIDを取得する

GetSPSListID# ListIDを取得するためのURLを生成する ListGet_URL = "https://graph.microsoft.com/v1.0/sites/" + \ SiteID + "/lists? + \ $filter=displayName eq '" + SPS_ListName + "'" # Microsoft Graphを実行し、その結果をres2に格納する。 res2 = requests.get( ListGet_URL, headers=headers ) # requrest処理をクローズする res2.close # res2をjsonファイルに整形 res2json = res2.json() # 結果からListIDを取得する ListID = res2json['value'][0]['id']res2jsonの取得結果

res2json{ "@odata.context": "https://graph.microsoft.com/v1.0/$metadata#sites('xxxxxxxx.sharepoint.com,xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx,xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx')/lists", "value": [ { "@odata.etag": "\"xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx,13\"", "createdDateTime": "2019-02-13T12:51:59Z", "description": "", "eTag": "\"xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx,13\"", "id": "xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx", "lastModifiedDateTime": "2019-02-14T13:16:31Z", "name": "IoT_Data", "webUrl": "https://https://xxxxxxxx.sharepoint.com/sites/zzzzzzzzzzzzzzzzzzzz/Lists/IoT_Data", "displayName": "IoT_Data", "createdBy": { "user": { "email": "xxx@xxx.com", "id": "xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx", "displayName": "テストユーザ" } }, "lastModifiedBy": { "user": { "email": "xxx@xxx.com", "id": "xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx", "displayName": "テストユーザ" } }, "parentReference": {}, "list": { "contentTypesEnabled": true, "hidden": false, "template": "genericList" } } ] }ここで詰まったところ

文字列をシングルクォート(')で囲っていたため

検索文字列をダブルクォート(")で囲うようにしてましたが

それだとエラーになったため

URL生成部分はダブルクォートにして以下のように宣言しました。"https://graph.microsoft.com/v1.0/sites/" + \ SiteID + "/lists? + \ $filter=displayName eq '" + SPS_ListName + "'"レコードIDを取得する

GetSPSRecordID# RecoardIDを取得するためのURLを生成する RecordGet_URL = "https://graph.microsoft.com/v1.0/sites/" + \ SiteID + "/lists/" + ListID + \ "/items?expand= + \ fields(select=Id," + SPS_SearchColumn + \ ")&filter=fields/" + SPS_SearchColumn + " eq '" + \ SPS_SearchRecord + "'" # Microsoft Graphを実行し、その結果をres3に格納する。 res3 = requests.get( RecordGet_URL, headers=headers ) # requrest処理をクローズする res3.close # res3をjsonファイルに整形 res3json = res3.json() # 結果からRecordIDを取得する RecordID = res3json['value'][0]['id']res3jsonの取得結果

res3json{ "@odata.context": "https://graph.microsoft.com/v1.0/$metadata#sites('xxxxxxxx.sharepoint.com,xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx,xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx')/lists('xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx')/items", "value": [ { "@odata.etag": "\"xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx,48752\"", "createdDateTime": "2019-02-14T13:16:31Z", "eTag": "\"xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx\"", "id": "2", "lastModifiedDateTime": "2019-02-18T13:12:05Z", "webUrl": "https://https://xxxxxxxx.sharepoint.com/sites/zzzzzzzzzzzzzzzzzzzz/Lists/IoT_Data/2_.000", "createdBy": { "user": { "email": "xxx@xxx.com", "id": "xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx", "displayName": "テストユーザ" } }, "lastModifiedBy": { "user": { "displayName": "SharePoint アプリ" } }, "parentReference": {}, "contentType": { "id": "0x01003F9D3A2ADE72BA4BBEA8AB7FCD7ECD6D" }, "fields@odata.context": "https://graph.microsoft.com/v1.0/$metadata#sites('xxxxxxxx.sharepoint.com,xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx,xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx')/lists('xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx')/items/$entity", "fields": { "@odata.etag": "\"xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxx,48752\"", "Product": "PiSensor", "id": "2" } } ] }ここで詰まったところ

検索クエリ部分ですね。

ここは試行錯誤するしかなかったです。

field で検索対象のリストからIDと検索対象のカラム名を指定し

filter関数で検索対象のカラム名のデータが何か?という指定をしています。まとめ

いかがだったでしょうか?

実運用で使用する場合は、やはりある程度変数化する必要があります。

今回、それを試していく中で、Microsoft Graph SharePoint の特性がちょっとわかった気がします。

みなさんのOffice365ライフで何かの足しになれば幸いです。

- 投稿日:2019-02-18T21:59:15+09:00

Pythonの組み込み関数69個を制覇する 第4回 h~i

Pythonでは、非常に多くの組み込み関数(Built-in Functions)が用意されており、ライブラリをimportせずとも様々な処理を行うことができます。

基本に立ち返って、組み込み関数の使い方を整理して行きたいと思います。

尚、実行例はWindows Subsystem for LinuxのUbuntu18.04にインストールしたPython3.7.1で作成しています。Pythonの組み込み関数69個を制覇する 第1回 a~b

Pythonの組み込み関数69個を制覇する 第2回 c~d

Pythonの組み込み関数69個を制覇する 第3回 e~g関数の使い方

各関数の使い方を記述していきます。詳細な使い方は他の記事に譲るとして、ここでは簡単な使用例を中心に掲載していきます。

hasattr()

オブジェクトに指定した属性が設定されているかを判定します。

第1引数に判定したいオブジェクトを、第2引数に判定したい属性名を渡します。>>> class Sushi(object): ... def __init__(self, neta, type): ... self.neta = neta ... self.type = type ... >>> maguro = Sushi('maguro', 'nigiri') >>> # 存在していたらTrue ... hasattr(maguro, 'neta') True >>> # 存在していなかったらFalse ... hasattr(maguro, 'taste') False >>> hasattr(maguro, 'type') Truehash()

引数には任意のオブジェクトをとり、そのハッシュ値を返します。

通常、ハッシュ値はオブジェクトのもつ__hash__()メソッドの結果を利用します。>>> hash(1) 1 >>> # 値が同じ場合はhash値は同じになる ... hash(1.0) 1 >>> hash(complex(1)) 1 >>> # 文字列 ... hash('key1') 7054912689230938466 >>> hash('key2') 4510368350215496904 >>> hash(object()) 8771476958276 >>> # __hash__()を実装するとhash()の返り値をコントロールできる ... class Hashi(object): ... def __hash__(self): ... return 2 ... >>> chopsticks = Hashi() >>> hash(chopsticks) 2ハッシュはdictで利用されるのですが、どのように使われるかはPython における hashable などがわかりやすいです。

help()

Pythonオブジェクトの説明を見ることができる非常に便利な関数です。

主にPythonの対話コンソールで使用します。引数なしで呼び出すと、対話的なヘルプが起動します。

>>> help() Welcome to Python 3.7's help utility! If this is your first time using Python, you should definitely check out the tutorial on the Internet at https://docs.python.org/3.7/tutorial/. Enter the name of any module, keyword, or topic to get help on writing Python programs and using Python modules. To quit this help utility and return to the interpreter, just type "quit". To get a list of available modules, keywords, symbols, or topics, type "modules", "keywords", "symbols", or "topics". Each module also comes with a one-line summary of what it does; to list the modules whose name or summary contain a given string such as "spam", type "modules spam". help>対話コンソールでは、オブジェクト名を入力することで、オブジェクトの説明文や持っているメソッド、属性などの情報を見ることができます。

help> str Help on class str in module builtins: class str(object) | str(object='') -> str | str(bytes_or_buffer[, encoding[, errors]]) -> str | | Create a new string object from the given object. If encoding or | errors is specified, then the object must expose a data buffer | that will be decoded using the given encoding and error handler. | Otherwise, returns the result of object.__str__() (if defined) | or repr(object). | encoding defaults to sys.getdefaultencoding(). | errors defaults to 'strict'. | | Methods defined here: (略)私の環境では、ヘルプページはlessコマンドと同じように操作することができました。

矢印キーやjkキーでの移動、/キーのあとに検索ワードを入力してドキュメント内の検索などができます。qキーでヘルプページから抜けます。

help>と表示されているときにquitまたはqと入力すると、ヘルプコンソールから抜けることができ、Pythonのプロンプトが表示されます。help> quit You are now leaving help and returning to the Python interpreter. If you want to ask for help on a particular object directly from the interpreter, you can type "help(object)". Executing "help('string')" has the same effect as typing a particular string at the help> prompt. >>>help()の引数にオブジェクトを渡すことで、ヘルプを表示することもできます。

>>> help(sum) Help on built-in function sum in module builtins: sum(iterable, start=0, \) Return the sum of a 'start' value (default: 0) plus an iterable of numbers When the iterable is empty, return the start value. This function is intended specifically for use with numeric values and may reject non-numeric types.help()関数は、オブジェクトの定義からヘルプドキュメントを生成しているので、自作の関数定義やクラス定義のヘルプを見ることもできます。

>>> class Fisherman(object): ... """釣り人""" ... def fish(self, feed:str) -> str: ... """何かを釣り上げる""" ... return 'can' ... >>> help(Fisherman)Help on class Fisherman in module __main__: class Fisherman(builtins.object) | 釣り人 | | Methods defined here: | | fish(self, feed: str) -> str | 何かを釣り上げる | | ---------------------------------------------------------------------- | Data descriptors defined here: | | __dict__ | dictionary for instance variables (if defined) | | __weakref__ | list of weak references to the object (if defined)hex()

引数に整数を渡すと、頭に

0xをつけた16進数の文字列に変換します。>>> hex(1) '0x1' >>> hex(16) '0x10' >>> hex(-99) '-0x63' >>> # floatはエラーになる ... hex(5.6) Traceback (most recent call last): File "<stdin>", line 2, in <module> TypeError: 'float' object cannot be interpreted as an integer >>> # floatを16進数にしたい場合は、float.hex()メソッドを使う ... 5.6.hex() '0x1.6666666666666p+2' >>> # intに戻すときは第2引数に底16を渡す ... int(hex(-99), 16) -99id()

引数に渡したオブジェクトの識別値を返します。

そのオブジェクトが有効である間は、常に一意の定数になることが仕様で保証されています。従って、あるオブジェクトが生存しているときに同じidになるような2つの変数は同じオブジェクトを指していることになります。

is演算子が真になるのはidの値が同一になる場合です。>>> # mutableなオブジェクトの例(int) ... x = 1 >>> id(1) 11151232 >>> id(x) 11151232 >>> x is 1 True >>> x += 1 >>> # idが変わる .... id(x) 11151264 >>> id(x) == id(2) True >>> x is 2 True >>> # mutableなオブジェクトの例(list) ... y = [] >>> id(y) 140495409735688 >>> y.append(1) >>> y [1] >>> id(y) 140495409735688 >>> # idが異なるので、別オブジェクト ... z = [1] >>> id(z) 140495410036168 >>> y is z FalseCPythonの実装では、id値はメモリ上のアドレス値になるとのことです。

input()

プロンプトを表示してユーザーからの入力を受け付け、結果を文字列として返します。

プロンプトは、引数で文字列として指定することができます。>>> result = input() Hello >>> print(result) Hello >>> name = input('名前を入力してね >>> ') 名前を入力してね >>> サブロー >>> print(name) サブロープログラム内でユーザーからの入力を受け付けることができるので非常に便利なinput()関数ですが、入力内容がプロンプトに表示されてしまうためパスワード入力には使えません。

パスワードの入力を対話的に行いたい場合はgetpassモジュールを使うのが良いでしょう。int()

整数型クラスのインスタンスオブジェクトを返却します。つまり、1や100や-9999などです。

引数には数値か、str, bytes, bytearrayといった文字列を扱うオブジェクトを渡すことができます。文字列の内容は'100'や'-200'といった 整数リテラルである必要があります。>>> # 何も渡さない場合は0 ... int() 0 >>> # 数値 ... int(100) 100 >>> int(45.0) 45 >>> int(30.5) 30 >>> int(-4.5555E3) -4555 >>> # 文字列 ... int('145') 145 >>> # bytes ... int(b'-490') -490 >>> # bytearray ... int(bytearray('50', 'ascii')) 50 >>> # 第2引数に基数を渡すことができる ... # 2進数 ... int('01001', 2) 9 >>> # 7進数 ... int('555', 7) 285 >>> # 8進数 ... int('0o555', 8) 365 >>> # 16進数 ... int('FFFF', 16) 65535引数に渡すオブジェクトに

__int__()や__trunc__()が定義されていた場合、それらの実行結果がint()の結果として返却されます。>>> # __int__()を実装する ... class MyInt(object): ... def __int__(self): ... return 42 ... >>> int(MyInt()) 42 >>> # __trunc__()を実装する ... class MyFloat(float): ... def __trunc__(self): ... import math ... return math.ceil(self) ... >>> int(MyFloat(5.5)) 5 >>> int(MyFloat(6.9)) 6isinstance()

指定したオブジェクトが、あるクラスのインスタンスかどうかを判定しTrue/Falseを返却します。親クラスや先祖クラスが比較対象の場合も同様に真を返します。

第1引数にオブジェクトを、第2引数にクラスを渡します。>>> isinstance(1, int) True >>> isinstance(1, str) False >>> # intを継承したクラス ... class NewInt(int): ... pass ... >>> isinstance(NewInt(1), int) True >>> # 抽象基底クラス(Abstract Base Class)の場合 >>> from abc import ABC >>> class MyABC(ABC):pass ... >>> class DEF(object):pass ... >>> isinstance(DEF(), MyABC) False >>> # 仮想クラスに登録すると、DEFはMyABCの子クラスとして認識される ... MyABC.register(DEF) <class '__main__.DEF'> >>> isinstance(DEF(), MyABC) True第2引数はクラスオブジェクトのタプルを渡すこともできます。その場合、要素のいずれかが対象の親(先祖)クラスであればTrueとなります。

>>> isinstance(10.5, (int, float, str)) True >>> isinstance(10.5, (int, str)) False >>> isinstance(10.5, ()) Falseissubclass()

指定したクラスオブジェクトが、あるクラスのサブクラスかどうかを判定しTrue/Falseを返却します。親クラスや先祖クラスが比較対象の場合も同様に真を返します。

第1引数にクラスオブジェクトを、第2引数にクラスを渡します。>>> issubclass(int, int) True >>> issubclass(NewInt, int) True >>> issubclass(NewInt, str) Falseiter()

iteratorオブジェクトを返します。

引数を一つまたは二つとり、それぞれのパターンで動きが変わるという少し癖のある関数です。

引数が一つの場合、__iter__()か__getitem()__をサポートしているオブジェクトである必要があります。forループの対象にできるものと考えれば問題ないでしょう。

iteratorオブジェクトをnext()関数に渡すと、要素を一つずつ返却し、最後の要素まで返却し終えるとStopIteration例外を送出します。大抵の場合は、forループで使用します。>>> i = iter([1, 2, 3]) >>> next(i) 1 >>> next(i) 2 >>> next(i) 3 >>> # 要素がなくなると例外 ... next(i) Traceback (most recent call last): File "<stdin>", line 1, in <module> StopIteration >>> for taste in iter(('Tonkotsu', 'Miso', 'Shoyu', 'Shio',)): ... print(taste, 'Ramen is Good.') ... Tonkotsu Ramen is Good. Miso Ramen is Good. Shoyu Ramen is Good. Shio Ramen is Good.iter()には第二引数としてsentinel、つまり番兵を渡すことができます。

この場合、第一引数は呼び出し可能(callable)なオブジェクトである必要があります。

このとき返却されるイテレータオブジェクトでは、__next__()が呼び出されるたびに第一引数オブジェクトを引数無しで呼び出し、返却される値が第二引数の値と同一であるとStopIterationを送出します。>>> x = 0 >>> def counter(): ... global x ... x += 1 ... return x ... >>> # ループのたびにcounter()が呼び出され、返り値が5のときに終了する >>> for i in iter(counter, 5): ... print(i) ... 1 2 3 4標準ドキュメント では、番兵を利用して、バイナリデータからブロックデータを読み込む方法を例として上げています。

第5回に続く

次回はlen()から

- 投稿日:2019-02-18T21:38:04+09:00

No.036【Python】正規表現「モジュール re」について

今回は、正規表現「モジュール re」について書いていきます。

I'll write about "re module", regular expression in python" on this page.

■ 文字列の先頭とパターン一致有無: match()関数

The judgement of agreement between a lead position of strings and a pattern: match()function

>>> import re >>> >>> w = "one two one two" >>> >>> # 文字列の先頭とパターンとの一致有無の確認:match() >>> >>> # re.match()にて調べることが可能 >>> >>> m = re.match("one",w) >>> >>> print(m) <re.Match object; span=(0, 3), match='one'> >>> # ↑ 一致の場合は、matchオブジェクトを返す>>> # matchオブジェクトは、以下のmethodを持つ >>> # group(), start(), end(), span(), etc. >>> >>> import re >>> >>> w = "one two one two" >>> >>> m = re.match("one",w) >>> print(m) <re.Match object; span=(0, 3), match='one'> >>> >>> print(m.group()) one >>> >>> print(m.start()) 0 >>> >>> print(m.end()) 3 >>> >>> print(m.span()) (0, 3)>>> # group():パターンに一致した全体を返す >>> # groups():()で囲まれた部分と一致した各文字列をタプルで取得可能 >>> >>> import re >>> w = "one two one two" >>> >>> m = re.match("(one) (two)",w) >>> >>> print(m) <re.Match object; span=(0, 7), match='one two'> >>> >>> print(m.group()) one two >>> >>> print(m.groups()) ('one', 'two') >>> >>> # 先頭に一致する文字列がない場合:Noneを返す >>> >>> m = re.match("two", w) >>> >>> print(m) None■ パターンの一致を調べる: search()

Search for pattern agreements

>>> # 先頭にない文字列を調べることが可能 >>> # re.match()と同様、一致の場合はmatchオブジェクトを返す >>> >>> import re >>> w = "one two one two" >>> >>> m = re.search("one",w) >>> >>> print(m) <re.Match object; span=(0, 3), match='one'> >>> >>> m = re.search("two",w) >>> >>> print(m) <re.Match object; span=(4, 7), match='two'> >>> #↑ 文字列中に一致箇所が複数あっても最初に一致したかのみ返す■ 一致箇所全てをリストで返す: findall()

Return all the part of agreement by lists

>>> # 一致箇所を全てリストにして返す >>> # 返すのはmatchオブジェクトではない >>> >>> import re >>> >>> w = "one two one two" >>> >>> m = re.findall("one",w) >>> >>> print(m) ['one', 'one'] >>> >>> m = re.findall("one two",w) >>> >>> print(m) ['one two', 'one two']■ 一致箇所全てをイテレータで返す: finditer()

Return all the part of agreement by iterators

>>> # re.finditer():一致箇所をmatchオブジェクトのイテレータで返す >>> # re.findallとは異なり、matchオブジェクトを得られる >>> >>> >>> import re >>> w = "one two one two" >>> >>> m = re.finditer('one', w) >>> >>> print(m) <callable_iterator object at 0x107b79fd0> >>> >>> for match in m: print(match) <re.Match object; span=(0, 3), match='one'> <re.Match object; span=(8, 11), match='one'>■ 一致箇所の置換:sub() / subn()

Replacement the part of agreement

>>> import re >>> w = "one two one two" >>> >>> m = re.sub("one", "ONE",w) >>> >>> print(m) ONE two ONE two >>> >>> m = re.sub("one two", "ONE TWO", w) >>> >>> print(m) ONE TWO ONE TWO >>> >>> #パターンの一部を囲み、置換後の文字列中の一致箇所を使用することが可能 >>> >>> m = re.sub("(one) (two)", "\\1X\\2",w) >>> >>> print(m) oneXtwo oneXtwo >>> >>> m = re.sub('(one) (two)', r'\1X\2', w) >>> >>> print(m) oneXtwo oneXtwo■ パターンによる文字列分割:split()

String division by patterns

>>> import re >>> w = "one two one two" >>> m = re.split(" ", w) >>> >>> print(m) ['one', 'two', 'one', 'two']■ 正規表現オブジェクトのコンパイル:compile()

Complie of regular expression obejcts

>>> # re.compile():同じパターンの繰り返し使用の場合 >>> # パターンをコンパイルして正規表現オブジェクトを生成したほうがいい >>> >>> import re >>> w = "one two one two" >>> >>> com = re.compile("one") >>> >>> m = com.match(w) >>> print(m) <re.Match object; span=(0, 3), match='one'> >>> >>> m = com.findall(w) >>> print(m) ['one', 'one'] >>> >>> m = com.sub("ONE", w) >>> print(m) ONE two ONE two随時に更新していきますので、

定期的な購読をよろしくお願いします。

I'll update my article at all times.

So, please subscribe my articles from now on.本記事について、

何か要望等ありましたら、気軽にメッセージをください!

If you have some requests, please leave some messages! by You-Tarinまた、「Qiita」へ投稿した内容は、随時ブログへ移動して行きたいと思いますので、よろしくお願いします。

- 投稿日:2019-02-18T21:22:42+09:00

Django Webアプリ作成(3) アプリケーション作成

環境

OS : macOS Mojave

Anaconda : python3.6.7

Django==2.1.5ここまでの流れ

前回でDjangoアプリの大枠を作成したので、今回から中身のアプリを作成していこうと思います。

作成したいWebアプリ

3回目で書くのもおかしいかもしれないが、まず作りたいアプリを決めないといけない。

作りたいものはいろいろあるが、最初ということでブログ形式のサイトを作ってみようと思う。

Django Girls チュートリアルを参考にして作成していく。アプリケーションの作成

Terminalpython manage.py startapp blog上のコードの"blog"は作成するアプリケーションの名前であり、好きな名前をつけて良い。

実行後のファイル構成は以下のようになる。djangoblog ├── blog │ ├── __init__.py │ ├── admin.py │ ├── apps.py │ ├── migrations │ │ └── __init__.py │ ├── models.py │ ├── tests.py │ └── views.py ├── config │ ├── __init__.py │ ├── __pycache__ │ │ ├── __init__.cpython-37.pyc │ │ ├── settings.cpython-37.pyc │ │ ├── urls.cpython-37.pyc │ │ └── wsgi.cpython-37.pyc │ ├── settings.py │ ├── urls.py │ └── wsgi.py ├── db.sqlite3 ├── manage.py ├── static └── templatesアプリの登録

設定ファイル(config/setting.py)に今作成したアプリを登録する。

config/setting.pyINSTALLED_APPS = [ 'django.contrib.admin', 'django.contrib.auth', 'django.contrib.contenttypes', 'django.contrib.sessions', 'django.contrib.messages', 'django.contrib.staticfiles', 'blog', ]アプリディレクトリ直下にurls.pyを作成

今回は1つのアプリケーションしか作らないが、2つ以上のアプリケーションを作成する場合はアプリケーションディレクトリにurls.pyを追加したほうがわかりやすくなる。

今後のためにも、今回はその方法で進める。Terminaltouch blog/urls.pyconfig/urls.pyとblog/urls.pyをつなぐ

config/urls.pyとblog/urls.pyを編集

config/urls.pyfrom django.contrib import admin from django.urls import path, include urlpatterns = [ path('admin/', admin.site.urls), path('', include('blog.urls')) ]blog/urls.pyfrom django.urls import include, path from . import views urlpatterns = [ ]次回以降にurls.pyの役割を書くがアプリディレクトリにurls.pyを作成することで、config/urls.pyが肥大化せずアプリごとに記述することでスリムなコードになる。

これでアプリの大枠は完成!

次回、アプリの中身を作成します!

- 投稿日:2019-02-18T21:05:28+09:00

AtomのHydrogenでMatplotlib, Bokeh, HoloViewsのプロットを表示する

はじめに

AtomのHydrogenでMatplotlib, Bokeh, HoloViewsのプロットを表示する方法です。

Matplotlib

import matplotlib.pyplot as plt plt.scatter([1, 2, 3], [1, 2, 3])Jupyter Notebookで必要な

%matplotlib inlineは要りません。

Bokeh

from bokeh.plotting import figure, output_notebook, show from bokeh.resources import INLINE output_notebook(INLINE) plot = figure() plot.circle([1, 2, 3], [1, 2, 3]) show(plot)

output_notebookがないと外部ブラウザにプロットが表示されてしまいます。INLINEは必ずしも必要ないですが、こうすると、BokehJS x.x.x successfully loaded.のメッセージが確認できます。HoloViews

プロットの準備

import numpy as np import pandas as pd import holoviews as hv xs = np.arange(-10, 10.5, 0.5) ys = 100 - xs**2 df = pd.DataFrame(dict(x=xs, y=ys)) curve = hv.Curve(df,'x','y')ここまでは特定の可視化ライブラリに依存していません。

バックエンドがMatplotlibの場合

hv.extension('matplotlib') hv.render(curve)バックエンドがBokehの場合

from bokeh.io import show hv.extension('bokeh') show(hv.render(curve))HoloViewsを通してBokehのプロット表示する際には、

output_notebookは不要です。また、Jupyter Notebookの場合は、curveをセルの最後に入力するだけでプロットが表示されますが、Hydrogenの場合は、hv.renderや(Bokehの場合には)showが必要となるようです。

- 投稿日:2019-02-18T21:05:28+09:00

AtomのHydrogenでMatplotlib, Bokeh, HoloViews他のプロットを表示する

はじめに

AtomのHydrogenでMatplotlib, Bokeh, HoloViewsのプロットを表示する方法です。

Matplotlib

import matplotlib.pyplot as plt plt.scatter([1, 2, 3], [1, 2, 3])Jupyter Notebookで必要な

%matplotlib inlineは要りません。

Bokeh

from bokeh.plotting import figure, output_notebook, show from bokeh.resources import INLINE output_notebook(INLINE) plot = figure() plot.circle([1, 2, 3], [1, 2, 3]) show(plot)

output_notebookがないと外部ブラウザにプロットが表示されてしまいます。INLINEは必ずしも必要ないですが、こうすると、BokehJS x.x.x successfully loaded.のメッセージが確認できます。HoloViews

プロットの準備

import numpy as np import pandas as pd import holoviews as hv xs = np.arange(-10, 10.5, 0.5) ys = 100 - xs**2 df = pd.DataFrame(dict(x=xs, y=ys)) curve = hv.Curve(df,'x','y')ここまでは特定の可視化ライブラリに依存していません。

バックエンドがMatplotlibの場合

hv.extension('matplotlib') hv.render(curve)バックエンドがBokehの場合

from bokeh.io import show hv.extension('bokeh') show(hv.render(curve))HoloViewsを通してBokehのプロット表示する際には、

output_notebookは不要です。また、Jupyter Notebookの場合は、curveをセルの最後に入力するだけでプロットが表示されますが、Hydrogenの場合は、hv.renderや(Bokehの場合には)showが必要となるようです。hvPlot

import pandas as pd import numpy as np idx = pd.date_range('1/1/2000', periods=1000) df = pd.DataFrame(np.random.randn(1000, 4), index=idx, columns=list('ABCD')).cumsum() import hvplot.pandas show(hv.render(df.hvplot()))Altair

import altair as alt import pandas as pd source = pd.DataFrame({ 'a': ['A', 'B', 'C', 'D', 'E', 'F', 'G', 'H', 'I'], 'b': [28, 55, 43, 91, 81, 53, 19, 87, 52] }) alt.Chart(source).mark_bar().encode(x='a', y='b')

- 投稿日:2019-02-18T21:05:28+09:00

AtomのHydrogenでMatplotlib, Bokeh, HoloViewsおよび他ライブラリのプロットを表示する

はじめに

AtomのHydrogenでMatplotlib, Bokeh, HoloViewsのプロットを表示する方法です。

Matplotlib

import matplotlib.pyplot as plt plt.scatter([1, 2, 3], [1, 2, 3])Jupyter Notebookで必要な

%matplotlib inlineは要りません。

Bokeh

from bokeh.plotting import figure, output_notebook, show from bokeh.resources import INLINE output_notebook(INLINE) plot = figure() plot.circle([1, 2, 3], [1, 2, 3]) show(plot)

output_notebookがないと外部ブラウザにプロットが表示されてしまいます。INLINEは必ずしも必要ないですが、こうすると、BokehJS x.x.x successfully loaded.のメッセージが確認できます。HoloViews

プロットの準備

import numpy as np import pandas as pd import holoviews as hv xs = np.arange(-10, 10.5, 0.5) ys = 100 - xs**2 df = pd.DataFrame(dict(x=xs, y=ys)) curve = hv.Curve(df,'x','y')ここまでは特定の可視化ライブラリに依存していません。

バックエンドがMatplotlibの場合

hv.extension('matplotlib') hv.render(curve)バックエンドがBokehの場合

from bokeh.io import show hv.extension('bokeh') show(hv.render(curve))HoloViewsを通してBokehのプロット表示する際には、

output_notebookは不要です。また、Jupyter Notebookの場合は、curveをセルの最後に入力するだけでプロットが表示されますが、Hydrogenの場合は、hv.renderや(Bokehの場合には)showが必要となるようです。hvPlot

import pandas as pd import numpy as np import holoviews as hv import hvplot.pandas from bokeh.plotting import show idx = pd.date_range('1/1/2000', periods=1000) df = pd.DataFrame(np.random.randn(1000, 4), index=idx, columns=list('ABCD')).cumsum() show(hv.render(df.hvplot()))Altair

import altair as alt import pandas as pd source = pd.DataFrame({ 'a': ['A', 'B', 'C', 'D', 'E', 'F', 'G', 'H', 'I'], 'b': [28, 55, 43, 91, 81, 53, 19, 87, 52] }) alt.Chart(source).mark_bar().encode(x='a', y='b')

- 投稿日:2019-02-18T20:54:20+09:00

XGBoostを使って競艇予測をしてみる

XGBoostを使って何かいいことしてみようということで、競艇予測をしてみます!開発環境はお財布が寂しい人は大好き、Google Colaboratory!

また、Gistにも投稿してます。そっちのが分かりやすいかも。

https://gist.github.com/Daisuke0209/d9e83e7105ff18afaa0c366fa42babfa

Google Driveへのアクセス

とりあえず、Google ColaboratoryからDriveにアクセスするためマウントを取ります

XGBoost_boat_prediction.ipynb#Google Driveのマウントを取る from google.colab import drive drive.mount('/content/gdrive')データの説明

各列ごとに、あるレースの色んな情報を意味。だいたい番組表+オッズのイメージ。これらのデータはPythonでスクレイピングして取ってきました。 以下に簡単な説明

- Date:レース日

- Place:レース会場

- Race:レースNo.

- Nth-rank:Nコース走者のランク(A1とかB2とか)をラベル化したもの

- Nth-num:Nコース走者の選手番号

- Nth-ratio:Nコース走者の単勝オッズ

- Nth-exb:展示のタイム

- 1st,2nd,3rd,4th,5th,6th:何走者が何位になったか (1st:5なら一位は5コース走者)

他にもいっぱいデータがありますが、ちょっと面倒なので省略。データの全体像見たい方は、Gistの投稿を見てみてください。予想するのはとりあえず1stにしましょう!

XGBoost_boat_prediction.ipynbimport pandas as pd df=pd.read_csv("/content/gdrive/My Drive/Datasets/boat_data/boat_data.csv") df.head()説明変数と目的変数をセットします。とりあえず使ってみるなので、説明変数も少なめで。。(;´・ω・)

XGBoost_boat_prediction.ipynb#目的変数 target=['1st'] #説明変数 features = ['Place','1st-rank','2nd-rank','3rd-rank','4th-rank','5th-rank','6th-rank', '1st-ratio','2nd-ratio','3rd-ratio','4th-ratio','5th-ratio','6th-ratio']学習データとテストデータの分割

とりあえず、8割を学習に使います。

XGBoost_boat_prediction.ipynbl = len(df) train_num = int(l*0.8) df_train = df[:train_num] df_test = df[train_num:l] X_train = df_train[features] X_test = df_test[features] y_train = df_train[target] y_test = df_test[target]モデル(XGBoost)の定義

XGBoost_boat_prediction.ipynbimport xgboost as xgb model=xgb.XGBClassifier()XGBoostモデルの学習

何のパラメータも設定していませんが、お試しということで(;´・ω・)

XGBoost_boat_prediction.ipynbmodel.fit(X_train, y_train)XGBoostの予測精度の評価

モデルの予測は1位になるのは何コースの走者かを出力します。

XGBoost_boat_prediction.ipynbimport matplotlib.pyplot as plt from sklearn.metrics import accuracy_score y_pred = model.predict(X_test) acc = accuracy_score(y_test, y_pred)*100 print('正答率は%.2f%です'%acc) plt.xlabel("Prediction of house value by XGBoost") plt.ylabel("Actual house value") plt.scatter(y_pred, df_test[target])正答率は55.51%です

(意味の無い散布図ですが。。。)

んん~。正答率55%がいいのか悪いのか。。。(;´・ω・) ということで、購入シミュレーションをしてみる競艇購入シミュレーション

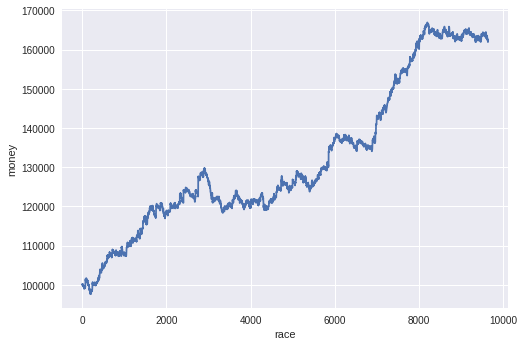

XGBoost_boat_prediction.ipynb#お財布 money = 100000 #一回あたりの掛け金 kake = 100 money_rireki = [] odds = df_test['1-odds'].values.tolist() #リスト化 y_test_ls = y_test.values.tolist() for i in range(len(y_pred)): #毎レースベットする money = money - kake #XGBoostの予想が合えば払い戻しを財布に入れる if y_pred[i] == y_test_ls[i]: money = money+kake*odds[i] money_rireki.append(money) plt.xlabel('race') plt.ylabel('money') plt.plot(money_rireki)おお(;´・ω・)めっちゃ増えとるやん!ほんまか!?

まとめ

嘘かほんとかよ―分かりませんが、なんかめちゃくちゃ儲かる結果になりました。間違えているところあれば教えてください。

- 投稿日:2019-02-18T20:54:20+09:00

XGBoostを使って競艇予測をしてみる(めっちゃ儲かる?)

XGBoostを使って何かいいことしてみようということで、競艇予測をしてみます!開発環境はお財布が寂しい人は大好き、Google Colaboratory!

また、Gistにも投稿してます。そっちのが分かりやすいかも。

https://gist.github.com/Daisuke0209/d9e83e7105ff18afaa0c366fa42babfa

Google Driveへのアクセス

とりあえず、Google ColaboratoryからDriveにアクセスするためマウントを取ります

XGBoost_boat_prediction.ipynb#Google Driveのマウントを取る from google.colab import drive drive.mount('/content/gdrive')データの説明

各列ごとに、あるレースの色んな情報を意味。だいたい番組表+オッズのイメージ。これらのデータはPythonでスクレイピングして取ってきました。 以下に簡単な説明

- Date:レース日

- Place:レース会場

- Race:レースNo.

- Nth-rank:Nコース走者のランク(A1とかB2とか)をラベル化したもの

- Nth-num:Nコース走者の選手番号

- Nth-ratio:Nコース走者の単勝オッズ

- Nth-exb:展示のタイム

- 1st,2nd,3rd,4th,5th,6th:何走者が何位になったか (1st:5なら一位は5コース走者)

他にもいっぱいデータがありますが、ちょっと面倒なので省略。データの全体像見たい方は、Gistの投稿を見てみてください。予想するのはとりあえず1stにしましょう!

XGBoost_boat_prediction.ipynbimport pandas as pd df=pd.read_csv("/content/gdrive/My Drive/Datasets/boat_data/boat_data.csv") df.head()説明変数と目的変数をセットします。とりあえず使ってみるなので、説明変数も少なめで。。(;´・ω・)

XGBoost_boat_prediction.ipynb#目的変数 target=['1st'] #説明変数 features = ['Place','1st-rank','2nd-rank','3rd-rank','4th-rank','5th-rank','6th-rank', '1st-ratio','2nd-ratio','3rd-ratio','4th-ratio','5th-ratio','6th-ratio']学習データとテストデータの分割

とりあえず、8割を学習に使います。

XGBoost_boat_prediction.ipynbl = len(df) train_num = int(l*0.8) df_train = df[:train_num] df_test = df[train_num:l] X_train = df_train[features] X_test = df_test[features] y_train = df_train[target] y_test = df_test[target]モデル(XGBoost)の定義

XGBoost_boat_prediction.ipynbimport xgboost as xgb model=xgb.XGBClassifier()XGBoostモデルの学習

何のパラメータも設定していませんが、お試しということで(;´・ω・)

XGBoost_boat_prediction.ipynbmodel.fit(X_train, y_train)XGBoostの予測精度の評価

モデルの予測は1位になるのは何コースの走者かを出力します。

XGBoost_boat_prediction.ipynbimport matplotlib.pyplot as plt from sklearn.metrics import accuracy_score y_pred = model.predict(X_test) acc = accuracy_score(y_test, y_pred)*100 print('正答率は%.2f%です'%acc) plt.xlabel("Prediction of house value by XGBoost") plt.ylabel("Actual house value") plt.scatter(y_pred, df_test[target])正答率は55.51%です

(意味の無い散布図ですが。。。)

んん~。正答率55%がいいのか悪いのか。。。(;´・ω・) ということで、購入シミュレーションをしてみる競艇購入シミュレーション

XGBoost_boat_prediction.ipynb#お財布 money = 100000 #一回あたりの掛け金 kake = 100 money_rireki = [] odds = df_test['1-odds'].values.tolist() #リスト化 y_test_ls = y_test.values.tolist() for i in range(len(y_pred)): #毎レースベットする money = money - kake #XGBoostの予想が合えば払い戻しを財布に入れる if y_pred[i] == y_test_ls[i]: money = money+kake*odds[i] money_rireki.append(money) plt.xlabel('race') plt.ylabel('money') plt.plot(money_rireki)おお(;´・ω・)めっちゃ増えとるやん!ほんまか!?

まとめ

嘘かほんとかよ―分かりませんが、なんかめちゃくちゃ儲かる結果になりました。間違えているところあれば教えてください。

- 投稿日:2019-02-18T20:17:47+09:00

事業活動の産業(大分類)別の売上高に天候が関係しているのか調べる。

概要

観光地は天候が良い、あるいは特殊だから観光地として成立しているはずで、天候のパラメータが少なからず影響していると考えたため。特に沖縄はそうであろうと考えたため分析しようと思いました。しかし一つやるも大分類すべてやるも手間は同じなので全部やります。

天候データを取得

こちらから取得させていただきました。

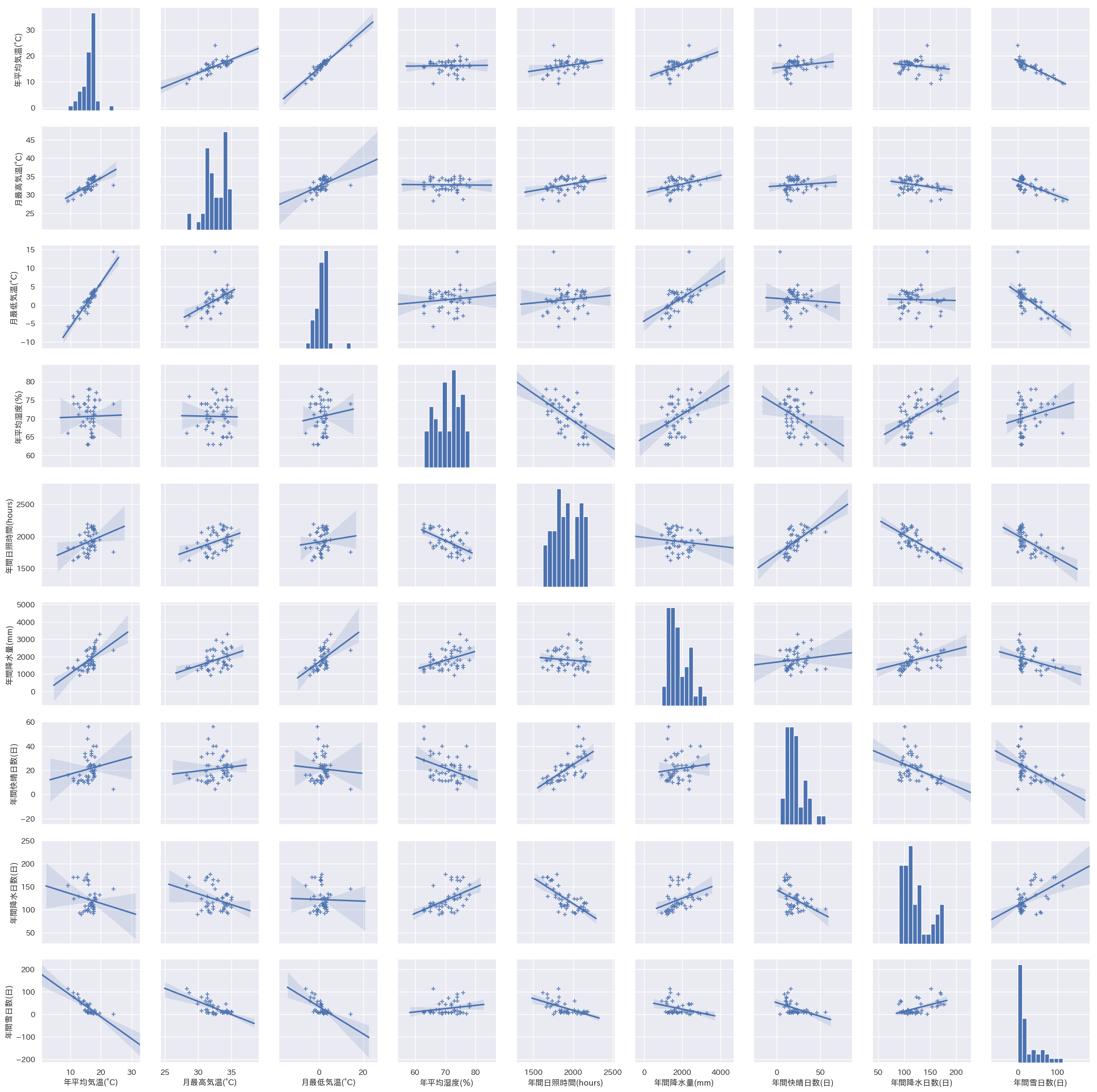

まずはざっとプロット

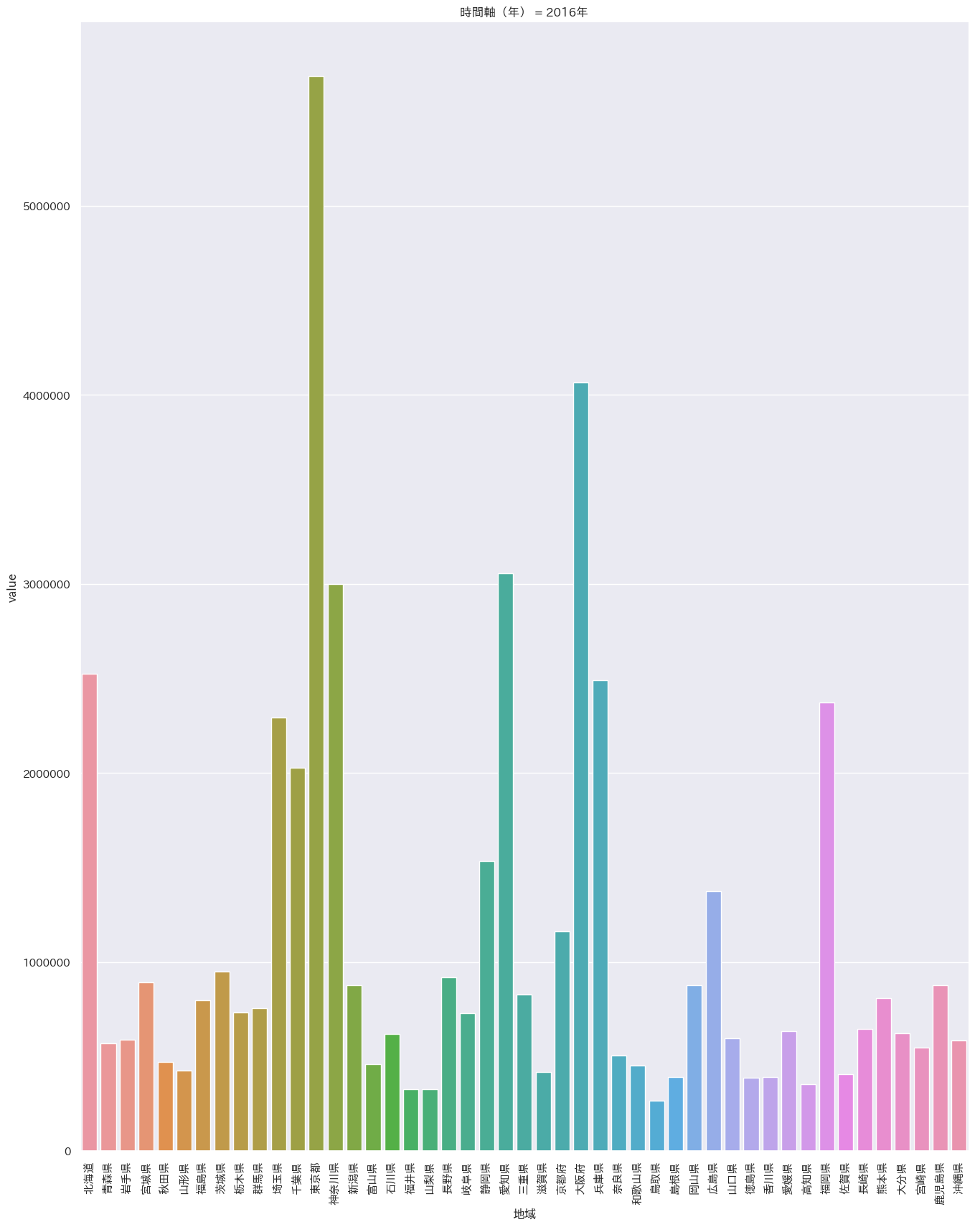

df = pd.read_csv('/Users/iMac/Dropbox/CSV/2016年の天候.csv') sns.pairplot(df,markers='+',kind='reg').savefig('test.png') plt.close('all') df = pd.melt(df, '都道府県') s= sns.catplot(x='都道府県', y='value', hue='variable', data=df, row=None, col='variable', col_wrap=3, estimator=np.mean, sharey=False) plt.savefig('test02.png') plt.close('all')沖縄は平均気温はダントツ(左上)だが

快晴日数は意外にも最下位(右下)

湿度も高く、依って沖縄は冴え渡る青空というよりもどんよりとしているけど蒸しているという状態のほうが多いと推定。閑話休題

2016年の都道府県事業活動の産業別年間売上データを整形

title = '総務省_0003216893_都道府県,事業活動の産業(大分類)別年間売上高_201601-201612.csv' df_01 = pd.read_csv(dir_path + title) # 統計局は取得できなかったデータはハイフン処理するので0変換 df_01["value"] = pd.to_numeric(df_01["value"], errors='coerce').fillna(0) # いらない情報を排除 drop_list = ['合計', '全国', '海外(海外支店(現地法人は含まない)等)'] for i in drop_list: df_01 = df_01[(df_01['地域'] != i)] & # 2016年の天候データをマージ df_03 = pd.read_csv(dir_path + '2016年の天候.csv') df_01 = pd.merge(df_01, df_03, left_on='地域', right_on='都道府県')上記により、各都道府県に天候データが貼り付けられました。カラム名が重複すると

x_、y_プレフィックスがつくので気をつけて下さい。各都道府県別の統計調査項目は以下の通りとなっている。

df_01['事業活動の産業'].unique() ''' ['サービス産業計(※「情報通信業」を除く。)' 'H運輸業,郵便業' 'K不動産業,物品賃貸業' 'L学術研究,専門・技術サービス業(※「学術・開発研究機関」及び「純粋持株会社」を除く。)' 'M宿泊業,飲食サービス業' 'N生活関連サービス業,娯楽業(※「家事サービス業」を除く。)' 'O教育,学習支援業(※「学校教育」を除く。)' 'P医療,福祉(*「保健所」,「社会保険事業団体」及び「福祉事務所」を除く。)' 'Rサービス業(他に分類されないもの)(※「政治・経済・文化団体」,「宗教」及び「外国公務」を除く。)'] '''なので、これをforでまわして全てまずはプロットさせてみます。そしてせっかく作った変数なので、そのまま

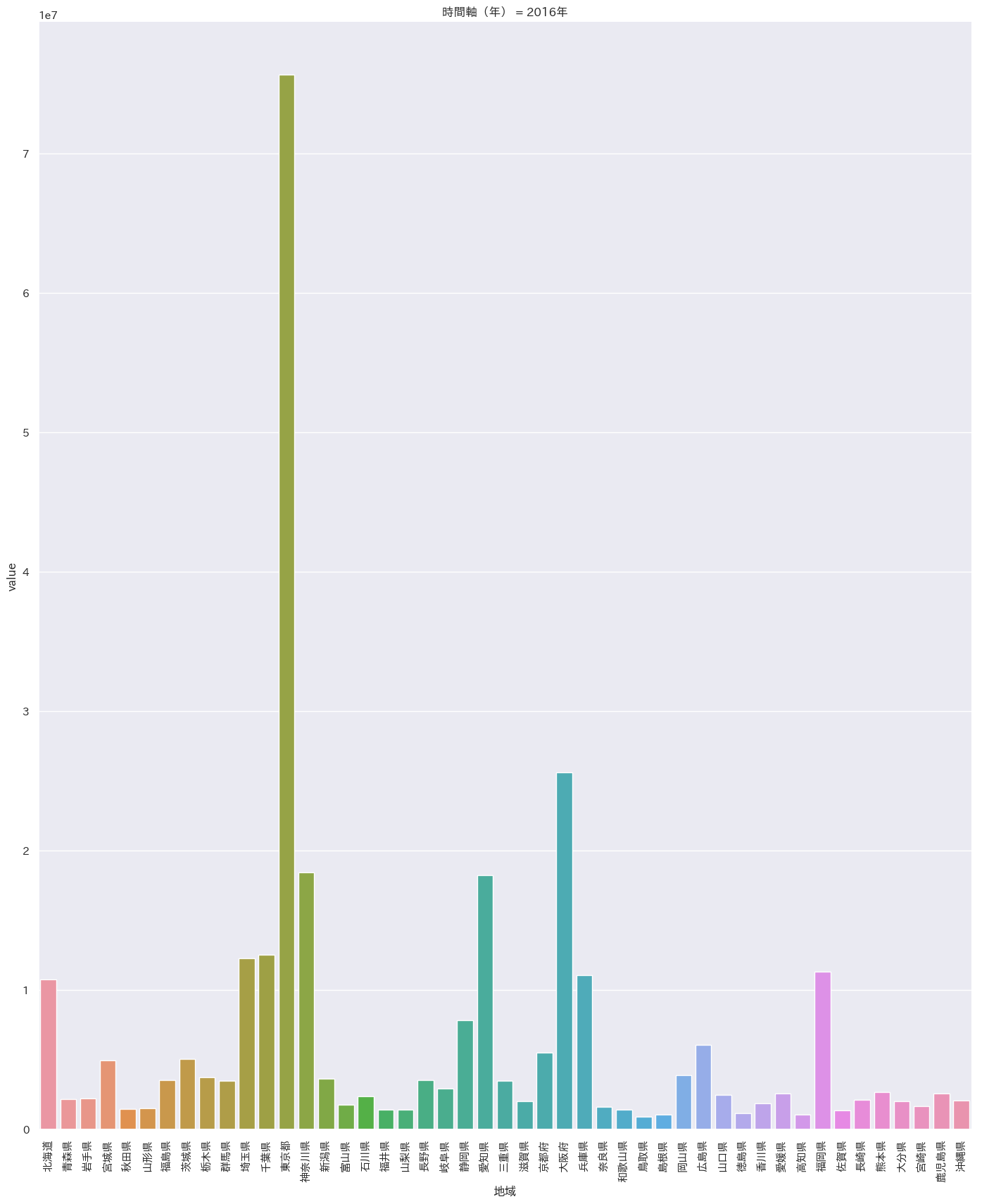

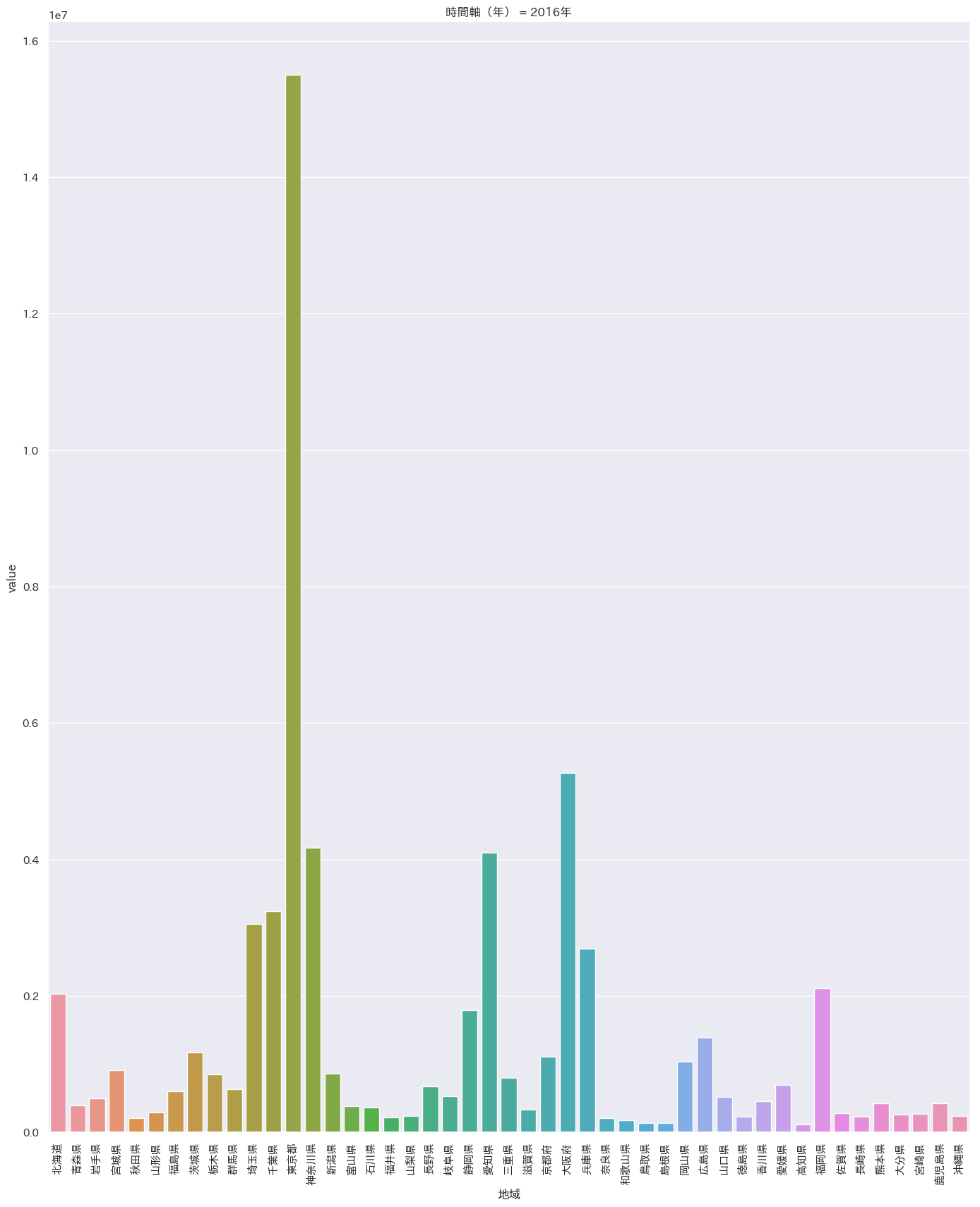

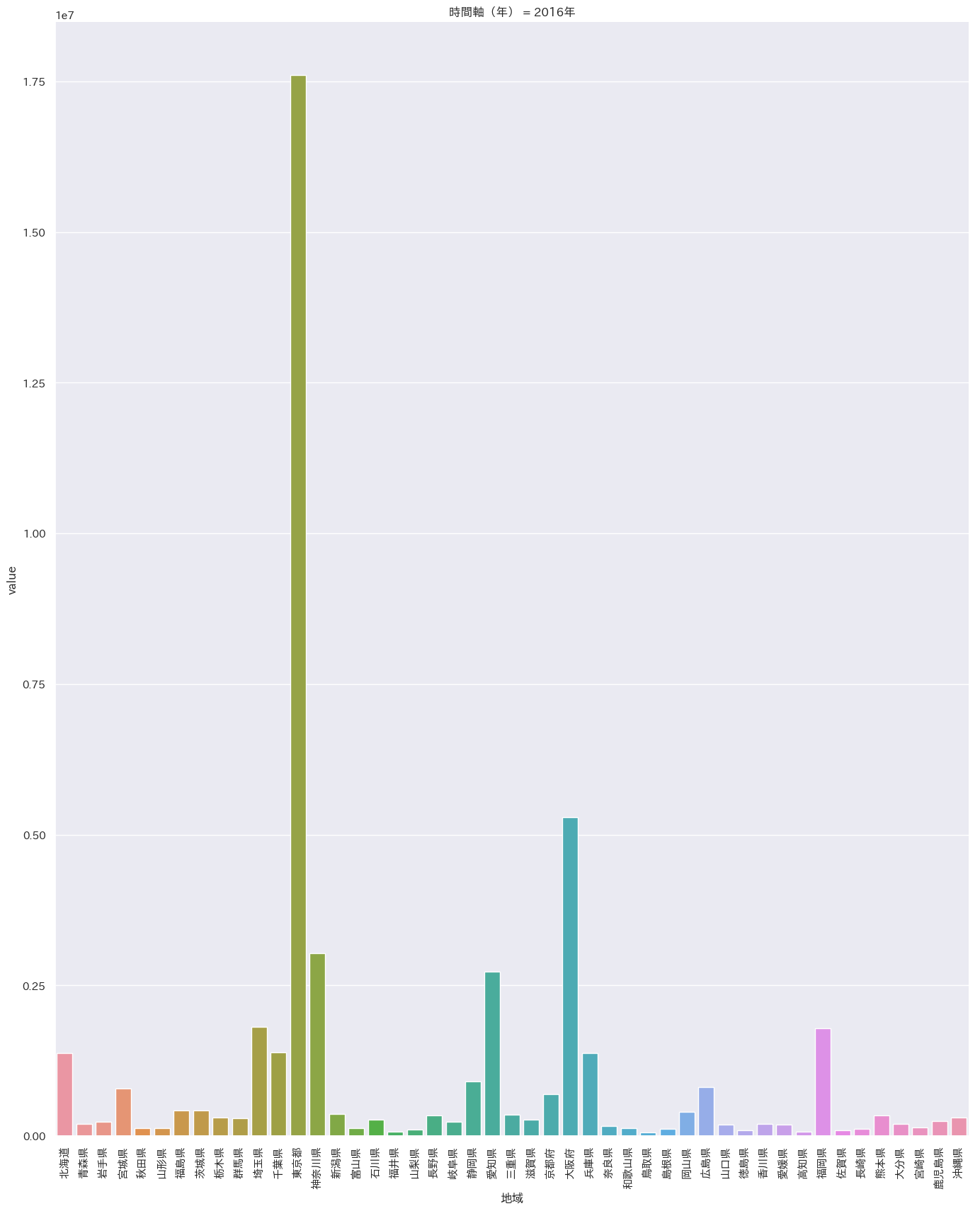

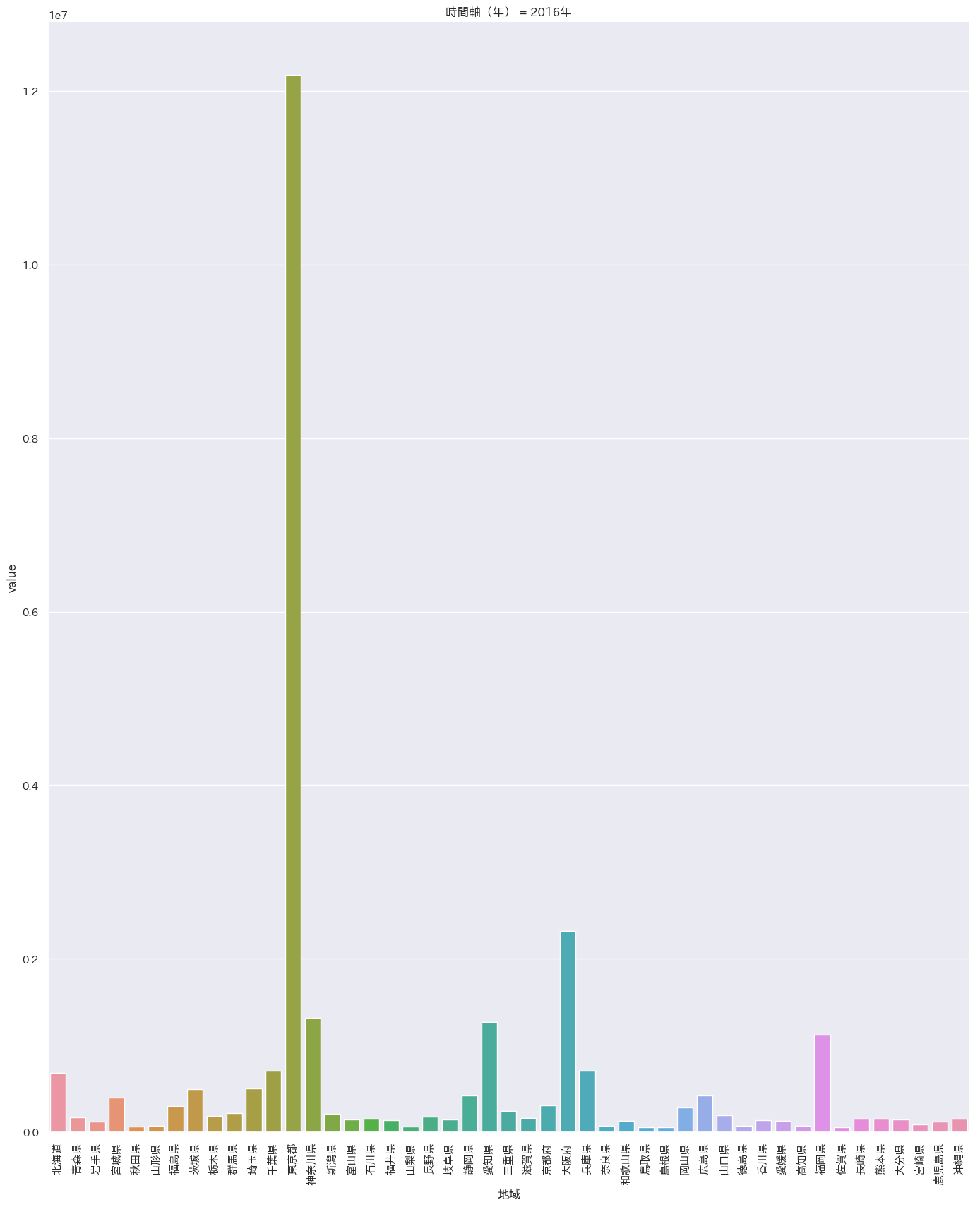

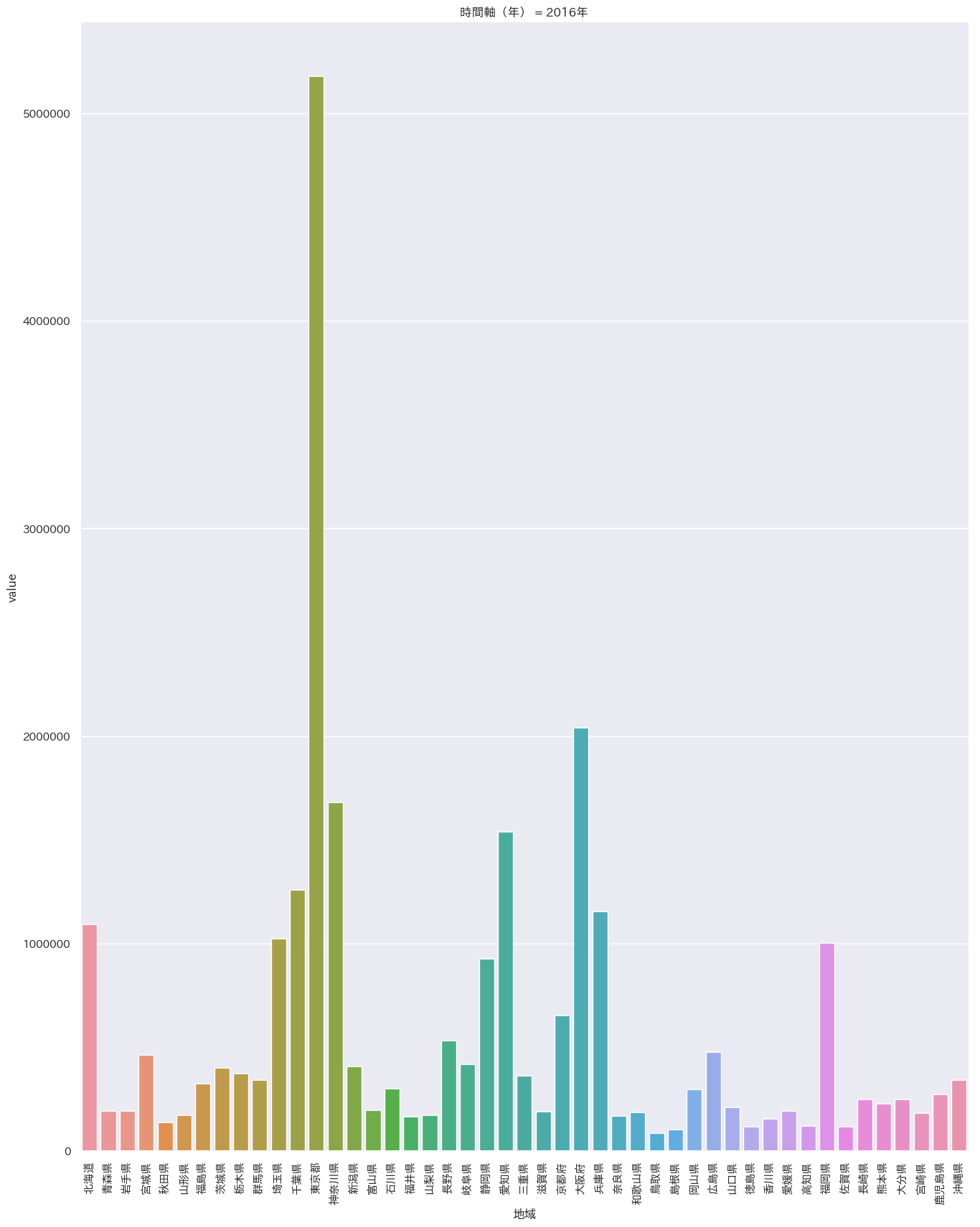

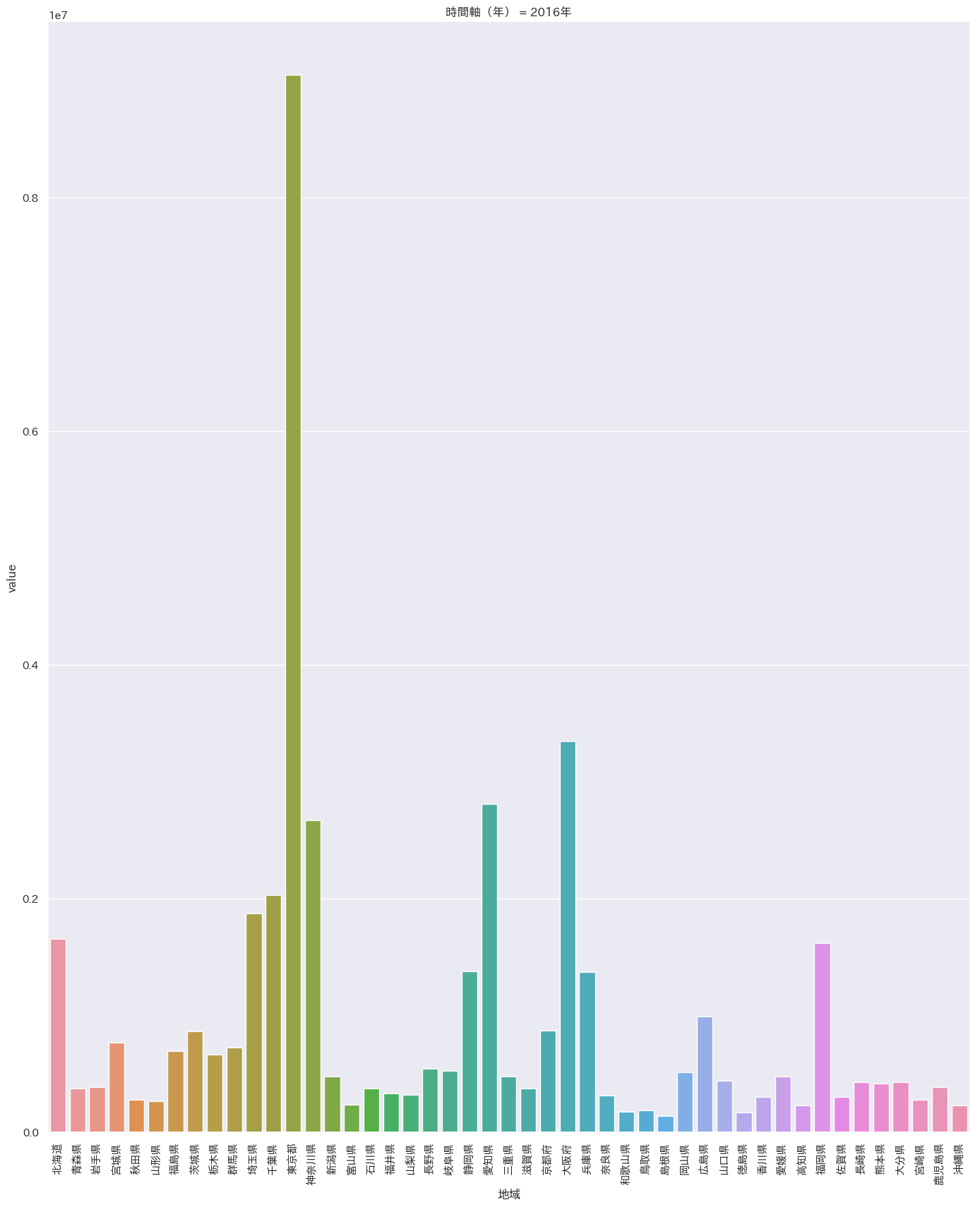

statsmodelsモジュールで重回帰分析をします。for i in df_01['事業活動の産業'].unique(): df_02=df_01[(df_01['事業活動の産業'] == i)] g = sns.catplot(x='地域', y='value', hue=None, data=df_01[(df_01['事業活動の産業'] == i)], row=None, col='時間軸(年)',col_wrap=2, estimator=np.mean, ci=95, n_boot=1000,col_order=None, kind="bar",legend=True, legend_out=True, sharex=True, sharey=False ) g.fig.set_figwidth(30) g.fig.set_figheight(20) g.set_xticklabels(df_01['地域'].unique(), rotation=90) g.savefig(title + i + '02.png') plt.close('all') # 説明変数 X = df_02[['年平均気温(°C)', '年平均湿度(%)','年間降水日数(日)', '年間雪日数(日)']] # 目的変数 Y = np.array(df_02['value']) model = smf.OLS(Y, X) result = model.fit() print('全国都道府県別産業別重回帰分析'+i) print(result.summary())'サービス産業計(※「情報通信業」を除く。)'

'H運輸業,郵便業'

'K不動産業,物品賃貸業'

'L学術研究,専門・技術サービス業(※「学術・開発研究機関」及び「純粋持株会社」を除く。)'

'M宿泊業,飲食サービス業'

'N生活関連サービス業,娯楽業(※「家事サービス業」を除く。)'

'P医療,福祉(*「保健所」,「社会保険事業団体」及び「福祉事務所」を除く。)'

'Rサービス業(他に分類されないもの)(※「政治・経済・文化団体」,「宗教」及び「外国公務」を除く。)東京が圧倒的です。。。

医療のみ偏差が少なそうなのが、高齢化社会を表していますね。

旅行産業は娯楽業に分類されます。

一番知りたかったのが天候と娯楽業の関係性なので見てみます。

全国都道府県別産業別重回帰分析N生活関連サービス業,娯楽業(※「家事サービス業」を除く。) OLS Regression Results ============================================================================== Dep. Variable: y R-squared: 0.307 Model: OLS Adj. R-squared: 0.242 Method: Least Squares F-statistic: 4.762 Date: Mon, 18 Feb 2019 Prob (F-statistic): 0.00286 Time: 20:07:56 Log-Likelihood: -731.94 No. Observations: 47 AIC: 1472. Df Residuals: 43 BIC: 1479. Df Model: 4 Covariance Type: nonrobust ============================================================================== coef std err t P>|t| [0.025 0.975] ------------------------------------------------------------------------------ 年平均気温(°C) 5.681e+04 1.76e+05 0.322 0.749 -2.99e+05 4.12e+05 年平均湿度(%) 7041.9821 4.34e+04 0.162 0.872 -8.06e+04 9.47e+04 年間降水日数(日) -3825.5116 1.2e+04 -0.319 0.751 -2.8e+04 2.04e+04 年間雪日数(日) -1603.0283 1.85e+04 -0.086 0.931 -3.9e+04 3.58e+04 ============================================================================== Omnibus: 75.362 Durbin-Watson: 1.320 Prob(Omnibus): 0.000 Jarque-Bera (JB): 953.684 Skew: 4.165 Prob(JB): 8.13e-208 Kurtosis: 23.436 Cond. No. 124. ============================================================================== Warnings: [1] Standard Errors assume that the covariance matrix of the errors is correctly specified.決定係数が低く、p値も5%を超えているので、信頼のおける結果ではなかったです。

区分が大雑把すぎたのと、

何年もデータを同じ地位域で取得しないと意味がなかったかもしれません。

次回やるときは同一県で、できるだけ長期のデータを用意するべきだと思いました。ついでなので、他のすべての分析も載せておきます。

全国都道府県別産業別重回帰分析サービス産業計(※「情報通信業」を除く。) OLS Regression Results ============================================================================== Dep. Variable: y R-squared: 0.239 Model: OLS Adj. R-squared: 0.168 Method: Least Squares F-statistic: 3.380 Date: Mon, 18 Feb 2019 Prob (F-statistic): 0.0172 Time: 20:07:50 Log-Likelihood: -830.60 No. Observations: 47 AIC: 1669. Df Residuals: 43 BIC: 1677. Df Model: 4 Covariance Type: nonrobust ============================================================================== coef std err t P>|t| [0.025 0.975] ------------------------------------------------------------------------------ 年平均気温(°C) 2.971e+05 1.44e+06 0.207 0.837 -2.6e+06 3.2e+06 年平均湿度(%) 6.222e+04 3.54e+05 0.176 0.861 -6.53e+05 7.77e+05 年間降水日数(日) -1.787e+04 9.79e+04 -0.183 0.856 -2.15e+05 1.79e+05 年間雪日数(日) -3.192e+04 1.51e+05 -0.211 0.834 -3.37e+05 2.73e+05 ============================================================================== Omnibus: 82.630 Durbin-Watson: 1.449 Prob(Omnibus): 0.000 Jarque-Bera (JB): 1354.051 Skew: 4.666 Prob(JB): 9.36e-295 Kurtosis: 27.583 Cond. No. 124. ============================================================================== Warnings: [1] Standard Errors assume that the covariance matrix of the errors is correctly specified. 全国都道府県別産業別重回帰分析H運輸業,郵便業 OLS Regression Results ============================================================================== Dep. Variable: y R-squared: 0.240 Model: OLS Adj. R-squared: 0.169 Method: Least Squares F-statistic: 3.398 Date: Mon, 18 Feb 2019 Prob (F-statistic): 0.0168 Time: 20:07:51 Log-Likelihood: -757.02 No. Observations: 47 AIC: 1522. Df Residuals: 43 BIC: 1529. Df Model: 4 Covariance Type: nonrobust ============================================================================== coef std err t P>|t| [0.025 0.975] ------------------------------------------------------------------------------ 年平均気温(°C) 7.201e+04 3.01e+05 0.240 0.812 -5.34e+05 6.78e+05 年平均湿度(%) 1.318e+04 7.41e+04 0.178 0.860 -1.36e+05 1.63e+05 年間降水日数(日) -5275.6075 2.04e+04 -0.258 0.798 -4.65e+04 3.6e+04 年間雪日数(日) -6376.5626 3.16e+04 -0.202 0.841 -7.01e+04 5.74e+04 ============================================================================== Omnibus: 78.551 Durbin-Watson: 1.321 Prob(Omnibus): 0.000 Jarque-Bera (JB): 1120.502 Skew: 4.375 Prob(JB): 4.85e-244 Kurtosis: 25.262 Cond. No. 124. ============================================================================== Warnings: [1] Standard Errors assume that the covariance matrix of the errors is correctly specified. 全国都道府県別産業別重回帰分析K不動産業,物品賃貸業 OLS Regression Results ============================================================================== Dep. Variable: y R-squared: 0.137 Model: OLS Adj. R-squared: 0.057 Method: Least Squares F-statistic: 1.708 Date: Mon, 18 Feb 2019 Prob (F-statistic): 0.166 Time: 20:07:52 Log-Likelihood: -761.14 No. Observations: 47 AIC: 1530. Df Residuals: 43 BIC: 1538. Df Model: 4 Covariance Type: nonrobust ============================================================================== coef std err t P>|t| [0.025 0.975] ------------------------------------------------------------------------------ 年平均気温(°C) -1.987e+04 3.28e+05 -0.061 0.952 -6.81e+05 6.42e+05 年平均湿度(%) 2.365e+04 8.09e+04 0.293 0.771 -1.39e+05 1.87e+05 年間降水日数(日) 299.3261 2.23e+04 0.013 0.989 -4.47e+04 4.53e+04 年間雪日数(日) -1.586e+04 3.45e+04 -0.460 0.648 -8.54e+04 5.37e+04 ============================================================================== Omnibus: 90.677 Durbin-Watson: 1.673 Prob(Omnibus): 0.000 Jarque-Bera (JB): 1948.813 Skew: 5.280 Prob(JB): 0.00 Kurtosis: 32.726 Cond. No. 124. ============================================================================== Warnings: [1] Standard Errors assume that the covariance matrix of the errors is correctly specified. 全国都道府県別産業別重回帰分析L学術研究,専門・技術サービス業(※「学術・開発研究機関」及び「純粋持株会社」を除く。) OLS Regression Results ============================================================================== Dep. Variable: y R-squared: 0.113 Model: OLS Adj. R-squared: 0.031 Method: Least Squares F-statistic: 1.371 Date: Mon, 18 Feb 2019 Prob (F-statistic): 0.260 Time: 20:07:53 Log-Likelihood: -742.28 No. Observations: 47 AIC: 1493. Df Residuals: 43 BIC: 1500. Df Model: 4 Covariance Type: nonrobust ============================================================================== coef std err t P>|t| [0.025 0.975] ------------------------------------------------------------------------------ 年平均気温(°C) -7.896e+04 2.2e+05 -0.360 0.721 -5.22e+05 3.64e+05 年平均湿度(%) 2.88e+04 5.41e+04 0.532 0.597 -8.03e+04 1.38e+05 年間降水日数(日) 1884.1298 1.49e+04 0.126 0.900 -2.82e+04 3.2e+04 年間雪日数(日) -1.586e+04 2.31e+04 -0.687 0.496 -6.24e+04 3.07e+04 ============================================================================== Omnibus: 97.599 Durbin-Watson: 1.804 Prob(Omnibus): 0.000 Jarque-Bera (JB): 2665.081 Skew: 5.845 Prob(JB): 0.00 Kurtosis: 37.989 Cond. No. 124. ============================================================================== Warnings: [1] Standard Errors assume that the covariance matrix of the errors is correctly specified. 全国都道府県別産業別重回帰分析M宿泊業,飲食サービス業 OLS Regression Results ============================================================================== Dep. Variable: y R-squared: 0.330 Model: OLS Adj. R-squared: 0.267 Method: Least Squares F-statistic: 5.286 Date: Mon, 18 Feb 2019 Prob (F-statistic): 0.00149 Time: 20:07:55 Log-Likelihood: -706.34 No. Observations: 47 AIC: 1421. Df Residuals: 43 BIC: 1428. Df Model: 4 Covariance Type: nonrobust ============================================================================== coef std err t P>|t| [0.025 0.975] ------------------------------------------------------------------------------ 年平均気温(°C) 6.414e+04 1.02e+05 0.627 0.534 -1.42e+05 2.7e+05 年平均湿度(%) -3245.7736 2.52e+04 -0.129 0.898 -5.41e+04 4.76e+04 年間降水日数(日) -2467.1229 6956.297 -0.355 0.725 -1.65e+04 1.16e+04 年間雪日数(日) 1739.5278 1.08e+04 0.162 0.872 -1.99e+04 2.34e+04 ============================================================================== Omnibus: 72.954 Durbin-Watson: 1.232 Prob(Omnibus): 0.000 Jarque-Bera (JB): 848.110 Skew: 4.006 Prob(JB): 6.84e-185 Kurtosis: 22.207 Cond. No. 124. ============================================================================== Warnings: [1] Standard Errors assume that the covariance matrix of the errors is correctly specified. 全国都道府県別産業別重回帰分析N生活関連サービス業,娯楽業(※「家事サービス業」を除く。) OLS Regression Results ============================================================================== Dep. Variable: y R-squared: 0.307 Model: OLS Adj. R-squared: 0.242 Method: Least Squares F-statistic: 4.762 Date: Mon, 18 Feb 2019 Prob (F-statistic): 0.00286 Time: 20:07:56 Log-Likelihood: -731.94 No. Observations: 47 AIC: 1472. Df Residuals: 43 BIC: 1479. Df Model: 4 Covariance Type: nonrobust ============================================================================== coef std err t P>|t| [0.025 0.975] ------------------------------------------------------------------------------ 年平均気温(°C) 5.681e+04 1.76e+05 0.322 0.749 -2.99e+05 4.12e+05 年平均湿度(%) 7041.9821 4.34e+04 0.162 0.872 -8.06e+04 9.47e+04 年間降水日数(日) -3825.5116 1.2e+04 -0.319 0.751 -2.8e+04 2.04e+04 年間雪日数(日) -1603.0283 1.85e+04 -0.086 0.931 -3.9e+04 3.58e+04 ============================================================================== Omnibus: 75.362 Durbin-Watson: 1.320 Prob(Omnibus): 0.000 Jarque-Bera (JB): 953.684 Skew: 4.165 Prob(JB): 8.13e-208 Kurtosis: 23.436 Cond. No. 124. ============================================================================== Warnings: [1] Standard Errors assume that the covariance matrix of the errors is correctly specified. 全国都道府県別産業別重回帰分析O教育,学習支援業(※「学校教育」を除く。) OLS Regression Results ============================================================================== Dep. Variable: y R-squared: 0.239 Model: OLS Adj. R-squared: 0.168 Method: Least Squares F-statistic: 3.369 Date: Mon, 18 Feb 2019 Prob (F-statistic): 0.0175 Time: 20:07:57 Log-Likelihood: -625.02 No. Observations: 47 AIC: 1258. Df Residuals: 43 BIC: 1265. Df Model: 4 Covariance Type: nonrobust ============================================================================== coef std err t P>|t| [0.025 0.975] ------------------------------------------------------------------------------ 年平均気温(°C) -1969.3981 1.81e+04 -0.109 0.914 -3.85e+04 3.46e+04 年平均湿度(%) 2082.7604 4465.986 0.466 0.643 -6923.758 1.11e+04 年間降水日数(日) -76.0979 1232.873 -0.062 0.951 -2562.424 2410.228 年間雪日数(日) -1142.2540 1905.750 -0.599 0.552 -4985.565 2701.057 ============================================================================== Omnibus: 78.308 Durbin-Watson: 1.205 Prob(Omnibus): 0.000 Jarque-Bera (JB): 1091.447 Skew: 4.370 Prob(JB): 9.89e-238 Kurtosis: 24.930 Cond. No. 124. ============================================================================== Warnings: [1] Standard Errors assume that the covariance matrix of the errors is correctly specified. 全国都道府県別産業別重回帰分析P医療,福祉(*「保健所」,「社会保険事業団体」及び「福祉事務所」を除く。) OLS Regression Results ============================================================================== Dep. Variable: y R-squared: 0.520 Model: OLS Adj. R-squared: 0.475 Method: Least Squares F-statistic: 11.65 Date: Mon, 18 Feb 2019 Prob (F-statistic): 1.71e-06 Time: 20:07:58 Log-Likelihood: -719.68 No. Observations: 47 AIC: 1447. Df Residuals: 43 BIC: 1455. Df Model: 4 Covariance Type: nonrobust ============================================================================== coef std err t P>|t| [0.025 0.975] ------------------------------------------------------------------------------ 年平均気温(°C) 1.824e+05 1.36e+05 1.344 0.186 -9.14e+04 4.56e+05 年平均湿度(%) -1.942e+04 3.35e+04 -0.580 0.565 -8.69e+04 4.81e+04 年間降水日数(日) -6610.4652 9238.144 -0.716 0.478 -2.52e+04 1.2e+04 年間雪日数(日) 1.228e+04 1.43e+04 0.860 0.395 -1.65e+04 4.11e+04 ============================================================================== Omnibus: 39.053 Durbin-Watson: 1.159 Prob(Omnibus): 0.000 Jarque-Bera (JB): 112.015 Skew: 2.271 Prob(JB): 4.75e-25 Kurtosis: 9.047 Cond. No. 124. ============================================================================== Warnings: [1] Standard Errors assume that the covariance matrix of the errors is correctly specified. 全国都道府県別産業別重回帰分析Rサービス業(他に分類されないもの)(※「政治・経済・文化団体」,「宗教」及び「外国公務」を除く。) OLS Regression Results ============================================================================== Dep. Variable: y R-squared: 0.214 Model: OLS Adj. R-squared: 0.140 Method: Least Squares F-statistic: 2.920 Date: Mon, 18 Feb 2019 Prob (F-statistic): 0.0319 Time: 20:07:59 Log-Likelihood: -733.38 No. Observations: 47 AIC: 1475. Df Residuals: 43 BIC: 1482. Df Model: 4 Covariance Type: nonrobust ============================================================================== coef std err t P>|t| [0.025 0.975] ------------------------------------------------------------------------------ 年平均気温(°C) 2.25e+04 1.82e+05 0.124 0.902 -3.44e+05 3.89e+05 年平均湿度(%) 1.012e+04 4.48e+04 0.226 0.822 -8.02e+04 1e+05 年間降水日数(日) -1801.3411 1.24e+04 -0.146 0.885 -2.67e+04 2.31e+04 年間雪日数(日) -5104.2400 1.91e+04 -0.267 0.791 -4.37e+04 3.34e+04 ============================================================================== Omnibus: 82.613 Durbin-Watson: 1.430 Prob(Omnibus): 0.000 Jarque-Bera (JB): 1352.360 Skew: 4.665 Prob(JB): 2.18e-294 Kurtosis: 27.566 Cond. No. 124. ============================================================================== Warnings: [1] Standard Errors assume that the covariance matrix of the errors is correctly specified.

- 投稿日:2019-02-18T19:54:57+09:00

Windowsのtreeをpathに変換するコードを書いてみた。

PCを初期化したとき、初期の構造を記憶するためにディレクトリ構造を取得したくて取得したのだが、

dir C:\\* /s /b /adで取得すればいいものを

treeで取得してしまった。でも今更もっかい初期化とかできないし。どうしよう。

そうだ、唯一使えるPythonを使ってPath化しよう!ということで書いた。

コード

ちなみに私はインデントにタブを使っている。タブが好きだからだ。クソコードごめんね

import os class DirectoryTreeChangeToPath: def __init__(self, path): paths = self.shaping(self.get_file_content(path)) with open(".\\changed_directory_tree_to_path.txt","x") as f: for i in paths: f.write(i + "\n") @staticmethod def get_file_content(path, mode="r", encoding='utf-8'): if os.path.exists(path): with open(path, mode=mode, encoding=encoding) as f: for i in f: yield i else: raise FileNotFoundError @staticmethod def shaping(default_dir_tree_data): directory = [next(default_dir_tree_data)[:-2]] for i in default_dir_tree_data: i = i.replace("\n", "", -1) i = DirectoryTreeChangeToPath.pipe_count(i) DirectoryTreeChangeToPath.merge(directory,i) yield "\\".join(directory) @staticmethod def merge(subject_,object_): if len(subject_) > object_[0]: del subject_[object_[0]:] return subject_.append(object_[1]) @staticmethod def pipe_count(string): indent = 0 while True: if string[:2] in ("└─","├─"): string = string[2:] indent += 1 break elif string[:3] == "│ ": string = string[3:] indent += 1 elif string[:4] == " ": string = string[4:] indent += 1 return indent,string def main(): os.chdir(os.path.dirname(__file__)) DirectoryTreeChangeToPath(".\\infomation\\default_dir_tree_data") main()書いてる間の思考

パイプをただのインデントとしてみたら簡単に数値に置換できた。

- 投稿日:2019-02-18T19:43:10+09:00

初心者です。for文の数字を1ずつ増やしたいです。

初心者です。調べて試してみたのですが上手く出来なかったので投稿しました。

サイトからスクレイピングを行いたいのですが

http://xxx.com/00001

などのスクレイピングするサイトの数字をfor文で数字を1ずつ増やして、

その作業を7万回行いたいです。import requests

response = requests.get("http://xxx.com/00001")

data = response.json()for item in data["vsrs"]:

print(item)現在この方法でスクレイピング出来ています。

しかしfor文が上手く行きません。num = 00001

for item in date(1, 70000):

num += 1

array[0] = [item]やURLの数字をitemに置き換えて

import requests

item = [n for n in range(3)]などを試したのですが上手く出来ません。

サイトの数字7万回を増やしたあと、vsrsのデータ全てを一箇所にまとめたいです。

質問の仕方が変な点もあるかと思いますがお願いします。mac

python3.7です。

- 投稿日:2019-02-18T18:50:18+09:00

【翻訳】Minimally Sufficient Pandas(全文)

Overview

この記事は

pandasクックブック-―Pythonによるデータ処理のレシピ の著者である Ted Petrou 氏の以下の記事、を、許諾を得て翻訳したものです。

https://twitter.com/arc279/status/1095511875050033152不自然な点、間違っている点などがありましたら指摘してもらえると助かります。

以下、翻訳です。

Minimally Sufficient Pandas(必要最低限の Pandas)

この記事では、データ分析にpandasを使用する際の、私の最適と思う意見を提案します。

私の目的は、データ分析のほとんどのケースでは、ライブラリの一部の機能だけで十分であることを主張することです。

ここで紹介する必要十分な最低限の機能は、 pandas の初心者からプロフェッショナルまで役に立つでしょう。

誰もが私の提案に同意するわけではないでしょうが、それらは私の実際のライブラリの使い方、あるいは教えている手法です。

もし、あなたが同意しないか、別の提案があるなら、以下のコメントに残してください。

(訳注:元記事のコメント欄)この記事を読み終わると

- Pandas の構文などではなく、実際のデータ分析に集中するためには、一部の機能に限定しても十分であることがわかります

- Pandas を用いた一般的な、多岐にわたるデータ分析のタスクに対する、具体的な単一アプローチの指針を持つことができます

100時間以上の無料のチュートリアル動画

私は、100時間以上にも及ぶ、Pandas, Matplotlib, Seaborn, そして Scikit-Learn の非常に詳細なチュートリアル動画を公開しています。(2019年の2月より)

ぜひ Dunder Data YouTube channel を購読して更新をチェックしてください。Upcoming Classes

よりパーソナライズされた授業が必要ならば、今年の3月に予定されている Machine Learning Bootcamps in NYC の私の講義に参加してください。

Pandas は強力だが扱いが難しい

Pandas はデータ分析者の間で最もポピュラーな python のライブラリです。

かなり多くの機能を提供していますが、学習コストが高いライブラリでもあります。

これにはいくつかの理由があります:

- 一般的なタスクをこなすのに複数の方法がある

- DataFrame には240を超えるメソッドと属性がある

- (基本的に同じコードを参照している)お互いのエイリアスであるメソッドがある

- ほぼ同じ機能のメソッドがある

- 同じ目的を達するのに、異なる人によって書かれたさまざまな方法によるチュートリアルが氾濫している

- 一般的なタスクを、慣用的な方法でこなす公式のガイドラインが存在しない

- 公式のドキュメントにも、慣用的でないコードが存在する

Pandas の必要最低限の機能はなにか?

データ分析ライブラリの目的は、分析者がデータ分析に集中できるツールを提供することです。

Pandas はまさにうってつけのツールですが、分析に集中できるようにはなっていません。

代わりに、ユーザは複雑で過剰な構文を覚えることを強要されます。私は Minimally Sufficient Pandas の定義として、以下を提案します。

- たいていの要求をこなすことができるのに十分な、ライブラリの機能の一部

- コードの書き方ではなくデータの分析に集中することができること

この Pandas の必要最低限のサブセットでは:

- 単純、明白、直接的で、退屈なコードになるでしょう

- あるタスクをこなすために、ただ1つの明白な方法を選ぶようになるでしょう

- そして毎回、明白な方法を選ぶでしょう

- 脳内の短期記憶に多くのコマンドを覚えておく必要はありません

- 他人やあなたにとって、より理解しやすいコードになるでしょう

よくあるタスクの標準化

Pandas はしばしば、同じタスクをこなすのに複数のアプローチを提供します。

これは、あなたの取ったアプローチが、他人のそれとは異なるかもしれないことを意味します。

これは、1列のカラムを選択する、などの最も基本的なタスクでも発生する可能性があります。

複数の異なるアプローチを採用しても、個人による単発の分析では、多くは問題にはならないでしょう。

しかし、多人数で長期間かかる分析において、それぞれが異なるアプローチを採用した場合、大混乱を引き起こす可能性があります。一般的なタスクに対して、標準的なアプローチを採用しないことによって、各自のアプローチの僅かな違いをすべて覚えておくための、大きな認知的負荷が開発者にかかります。

各人が一般的なタスクをこなすために、それぞれの好む方法を採用することは、エラーと非効率を引き起こします。Stack Overflow の雪崩

Stack Overflow で Pandas に関する質問を検索すると、よくある一般的なタスクに対して、複数の競合するさまざまな結果が得られることは、珍しくありません。

DataFrameの列名の変更に関するこの質問には28の回答があります。

あるタスクをこなすために慣用的な方法を1つ知りたい人にとって、この大量の情報に目を通すことは非常に困難です。No Tricks

ライブラリの大部分を削ることには、いくつかの(良い)制限があります。

あいまいな Pandas のトリックをたくさん知っていることは、あなたの友達にドヤれるかもしれませんが、たいてい良いコードに繋がることはありません。

それどころか、理解しがたく、そしてデバッグがより困難な長大なコードを生み出すでしょう。Pandas の具体例

では、タスクをこなすために複数のアプローチが存在する Pandas の、具体例について説明します。

異なるアプローチを比較対照して、どちらのアプローチが望ましいかについての指針を示します。トピックは以下のとおりです:

- 単一の列を選択する

ixインデクサは非推奨atiatによるセルの選択read_csvとread_tableは重複isnaとisnull、notnaとnotnull- 算術演算子および比較演算子と、それらに対応するメソッド

- python の組み込み関数と、同名の Pandas の同名のメソッド

groupbyによる集計方法の統一- MultiIndex の扱いかた

groupbypivot_tablecrosstabの違いpivotとpivot_tablemeltとstackの類似点pivotとunstackの類似点必要最低限のガイドライン

具体例は全て以下の原則に則っています。

あるメソッドが他のメソッドよりも追加の機能を提供していない場合(つまり、その機能が他のメソッドのサブセットである場合)、それを使用するべきではありません。メソッドは、追加の独自の機能がある場合にのみ検討する必要があります。

単位の列を選択

Pandas の DataFrameから1列のデータを選択することは、最も簡単なタスクにでありながら、残念ながら、Pandas の提供する複数の手法にユーザが最初に直面するケースです。

ブラケット (

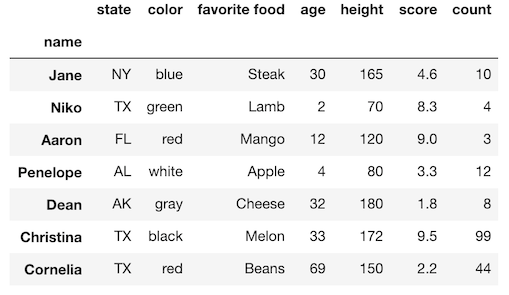

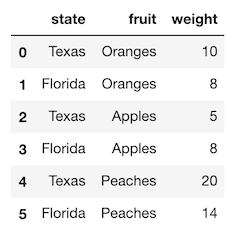

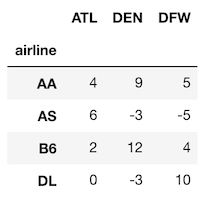

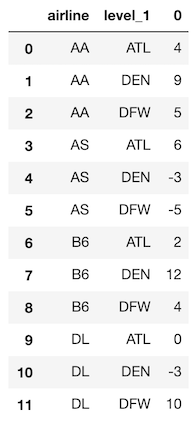

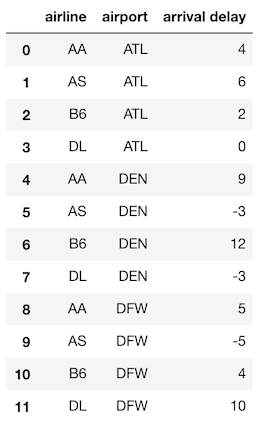

[]) またはドット表記を使用して、単一の列をシリーズとして選択できます。小さな DataFrame から、両方の方法を使用して列を選択してみましょう。>>> import pandas as pd >>> df = pd.read_csv('data/sample_data.csv', index_col=0) >>> df|以下、使用する簡単な DataFrame のサンプル|

|--|

||

ブラケット表記での選択

DataFrame の括弧の中に列名を指定すると、単一の列が Series として選択されます。

>>> df['state'] name Jane NY Niko TX Aaron FL Penelope AL Dean AK Christina TX Cornelia TX Name: state, dtype: objectドット表記での選択

あるいは、ドット表記を使用して単一の列を選択することも出来ます。出力は上記と全く同じです。

>>> df.stateドット表記の問題点

ドット表記には3つの問題点があります。以下の状況では機能しません:

- 列名にスペースが入っているとき

- 列名が DataFrame のメソッドと同じ名前であるとき

- 列名を変数で指定したいとき

列名にスペースが入っているとき

もし必要なカラム名にスペースが入っていると、ドット表記では指定することが出来ません。

Python はスペースを変数名、演算子の区切りとして扱うため、したがって、スペースを含む列名は正しい構文として扱われません。

エラーを起こしてみましょう。df.favorite food列名にスペースを含む列の取得はブラケット表記を用いる必要があります。

df['favorite food']列名が DataFrame のメソッドと同じ名前であるとき

列の名前と DataFrame のメソッド名が競合した場合、 Pandas は常に列名ではなくメソッドを参照します。

例えば、列名countはメソッドなので、ドット表記で参照されます。

Python はメソッド自体を参照できるため、実際にはエラーになりません。

(訳注:python の関数は first-class object)

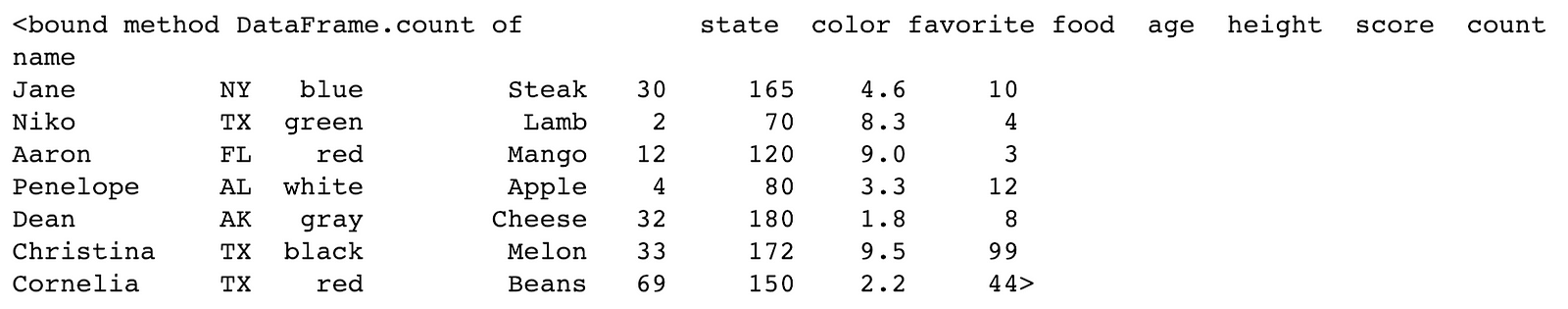

では、メソッドを参照してみましょう。df.count初めて遭遇した場合、非常に混乱するでしょう。

1行目にbound method DataFrame.count ofと記載されています。

これは DataFrame の object の保持する何らかのメソッドである、とPythonは教えてくれます。

メソッド名の代わりに、公式な文字列表現(訳注:repr()を適用したもの)を出力します。

多くの人は、この出力を見て、何らかの分析を行った結果だと勘違いするでしょう。

しかしこれは正しくなく、ほとんど何も起こっておらず、ただオブジェクトの表現を出力するメソッドへの参照が作成さました。

それだけです。ドット表記を使用して、列が Series として選択されなかったことは明らかです。

繰り返しますが、DataFrame メソッドと同じ名前の列を選択するときは、ブラケット表記を使用する必要があります。df['count']列名を変数で指定したいとき

選択したい列名を変数に保持していたとしましょう。

この場合もブラケットを使用することが唯一の手法です。

以下は、列名の値を変数に代入してから、この変数をブラケットに渡す単純な例です。>>> col = 'height' >>> df[col]ブラケット表記はドット表記のスーパーセットである

ブラケット表記は、単一の列を指定する機能としては、ドット表記のスーパーセットです。

ドット表記では扱えない3つのケースを紹介しました。多くの Pandas はドット表記で書かれています。なぜ?

多くのチュートリアルで、単一の列を選択するのにドット表記が使われています。

ブラケット表記のほうが明らかに優れているのに、なぜでしょうか?

公式のドキュメントの多くの例に使われていたりしますし、3文字多いタイピングが面倒に感じるからかもしれません。ガイダンス:データの列を選択する際にはブラケット表記を使用する

ドット表記はブラケット表記よりも多くの機能を追加せず、使えないシチュエーションも存在します。

そのため、私は決して使いません。

唯一の利点は、3文字少ないキーストロークです。単一のデータ列を選択する際にはブラケット表記のみを使用することをお勧めします。

この非常に一般的なタスクに対して、アプローチを統一するだけで、 Pandas のコードは遥かに一貫性のあるものになります。

ixインデクサは非推奨です、使ってはいけませんPandas は行を選択する際に、ラベルでの指定と、整数での位置指定を提供しています。

この一見柔軟な2通りの方法は、初学者にとって大きな混乱の原因になります。

ixインデクサは、ラベルと整数位置の両方で行と列を選択するために、Pandas の初期に作成されましたが、

Pandas の行と列の名前は、整数と文字列どちらにもなり得ることがあるため、これはかなり曖昧で有ることが判明しました。これを明示的に選択するために、

locとilocインデクサが実装されました。

locインデクサーはラベルのみ、ilocインデクサーは整数位置のみに対して使用できます。

ixインデクサは多目的でしたが、locilocインデクサの登場により推奨されなくなりました。ガイダンス: 全ての

ixの痕跡を削除し、locおよびilocに置き換えてください

atiatによる選択DataFrame 内の単一のセルをを選択するために、さらなる2つのインデクサである

atiatが存在します。

これらは、類似のlocilocインデクサに比べて、わずかにパフォーマンスの面で優れています。

しかし、それらの機能を追加でさらに覚えておかなければならない負担ももたらします。

また、ほとんどのデータ分析において、大規模でない限りは、パフォーマンスの向上は役に立ちません。

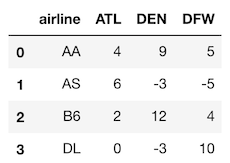

そして、本当にパフォーマンスが問題になるケースでは、DataFrame から NumPyの配列に変換することで、パフォーマンスは大幅に向上します。パフォーマンス比較:

ilocvsiatvsNumPy単一セルを選択するケースで、

iloc、iat、 NumPy配列のパフォーマンスを比べてみましょう。

ランダムデータを含む 100k行 5列 のNumPy配列を作成します。

それを元に DataFrame に変換して、試してみましょう。>>> import numpy as np >>> a = np.random.rand(10 ** 5, 5) >>> df1 = pd.DataFrame(a) >>> row = 50000 >>> col = 3 >>> %timeit df1.iloc[row, col] 13.8 µs ± 3.36 µs per loop >>> %timeit df1.iat[row, col] 7.36 µs ± 927 ns per loop >>> %timeit a[row, col] 232 ns ± 8.72 ns per loop

ilocに比べてiatは2倍の速度も出ない一方、 NumPy配列では約60倍も速度が向上します。

パフォーマンス要件を満たすアプリケーションが本当にあるのであれば、Pandas ではなく NumPy を直接使用するべきです。ガイダンス:単一セル選択に本当にパフォーマンスが必要な場合は、

atiatではなく、 NumPy配列を使用してくださいメソッドの重複

Pandas には全く同じことをするメソッドが複数あります。

2つのメソッドが内部で全く同じ機能を使用している場合は、常に、それらは互いのエイリアスであると言います。

ライブラリ内で同じ機能の重複は完全に不要であり、名前空間を汚染し、分析者に余計な情報を覚えておくよう強制します。次のセクションでは、いくつかの重複したメソッド、あるいはよく似たメソッドについて説明します。

read_csvとread_tableの重複重複の例として、

read_csvとread_table関数を挙げましょう。

どちらもテキストファイルからデータを読み込んで、まったく同じことを行います。

唯一の違いは、read_csvがデフォルトのセパレータがカンマであるのに対して、read_tableはタブ文字であることです。

read_csvとread_tableが同じ結果になることを確認しましょう。

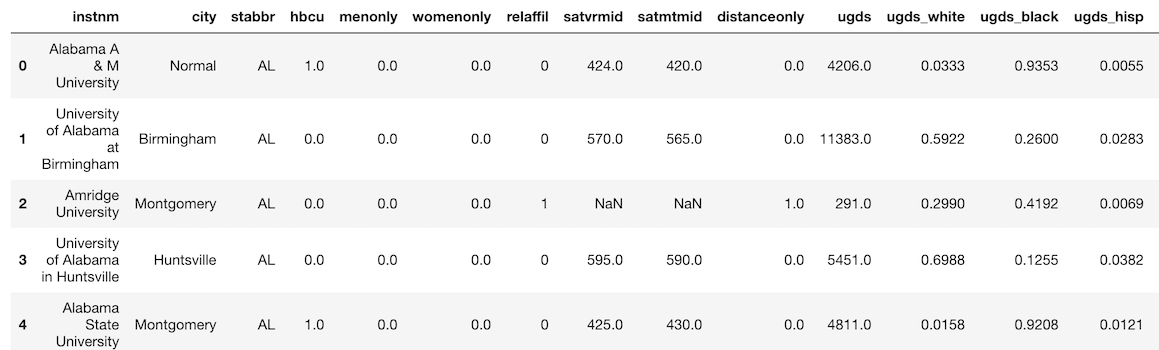

サンプルデータとして、public な College Scoreboard dataset を使用します。

equalsメソッドは、2つの DataFrameがまったく同じ値を持つかどうかを確認します。>>> college = pd.read_csv('data/college.csv') >>> college.head()>>> college2 = pd.read_table('data/college.csv', delimiter=',') >>> college.equals(college2) True

read_tableは非推奨です私は、非推奨としたほうが良いと思う関数とメソッドに関して、

Pandas の Githubリポジトリ に Issue を出しています。

read_tableメソッドは非推奨のため、使用しないでください。ガイダンス:区切り文字付きテキストファイルを読み込む場合は

read_csvのみを使用してください

isnavsisnullとnotnavsnotnull

isnaisnullメソッドはどちらも、DataFrame内に欠損値があるかどうかを判別します。

結果は常に bool 値の DataFrame (あるいは Series)になります。これらのメソッドは完全に同じです。

一方が他方のエイリアスである、と前の段落で言った通り、両方は必要ありません。

naという欠損値を表す文字列が、他に欠損値を扱うdropnafillnaといったメソッド名に追加されたため、 それに合わせてisnaメソッドも追加されました。

紛らわしいことに、Pandas は欠損値の表現としてNaNNoneNaTを使用していますが、NAは使用しません。

notnaとnotnullはお互いのエイリアスであり、単にisnaの反対を返します。これも両方は必要ありません。

isnaがisnullのエイリアスであることを確認しましょう。>>> college_isna = college.isna() >>> college_isnull = college.isnull() >>> college_isna.equals(college_isnull) True私は

isnanotnaしか使いませんサフィックスに

naが付いているメソッドを使用することで、他の欠損値メソッドdropnafillnaの名前と整合が取れます。Pandasは bool 値の DataFrame を反転するための演算子

~を提供しているため、notnaの使用を避けることもできます。ガイダンス:

isnaとnotnaを使いましょう(訳注)

isnullnotnullではなく算術演算子、比較演算子とそれに対応するメソッド

全ての算術演算子には、同等の機能を提供するメソッドがあります。

(訳注:表にしました)

|op|method|

|-|-|-|

|+|add|

|-|subsubtract|

||mulmultiply|

|/|divdividetruediv|

|*|pow|

|//|floordiv|

|%|mod|全ての比較演算子にも、同等の機能のメソッドがあります。

|op|method|

|-|-|-|

|>|gt|

|<|lt|

|>=|ge|

|<=|le|

|==|eq|

|!=|ne|

ugds列(undergraduate population の略)のSeriesを選択し、100を加えることで、

+演算子とそれに対応するメソッドの両方で同じ結果が得られることを確認しましょう。>>> ugds = college['ugds'] >>> ugds_operator = ugds + 100 >>> ugds_method = ugds.add(100) >>> ugds_operator.equals(ugds_method) True各学校の zスコアを計算する

もう少し複雑な例を見てみましょう。

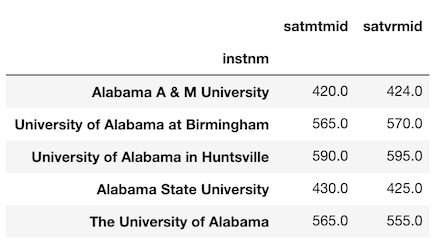

以下では、 institution 列をインデックスにセットして、SAT列を選択します。

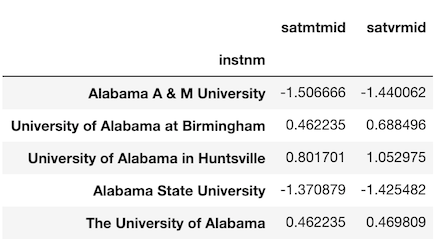

これらのスコアを提供していない学校はdropnaで落とします。>>> college_idx = college.set_index('instnm') >>> sats = college_idx[['satmtmid', 'satvrmid']].dropna() >>> sats.head()各大学の SATスコアの z-score に興味があるとしましょう。

(訳注:名前が紛らわしいですが z-score はいわゆる偏差値で、SATスコアが計算対象のスコアです)

これを計算するには、平均値を引き、標準偏差で割る必要があります。

まず各列の平均と標準偏差を計算しましょう。>>> mean = sats.mean() >>> mean satmtmid 530.958615 satvrmid 522.775338 dtype: float64 >>> std = sats.std() >>> std satmtmid 73.645153 satvrmid 68.591051 dtype: float64算術演算子を使った計算結果を見てみます。

>>> zscore_operator = (sats - mean) / std >>> zscore_operator.head()メソッドを使った方法も算出して、結果を比べてみましょう。

>>> zscore_methods = sats.sub(mean).div(std) >>> zscore_operator.equals(zscore_methods) True実際にメソッドが必要になる場合

いまの所、演算子よりもメソッドを使ったほうが良い場面には出会ったことがありません。

メソッドを使用する場合でしか対応できないケースを見てみましょう。

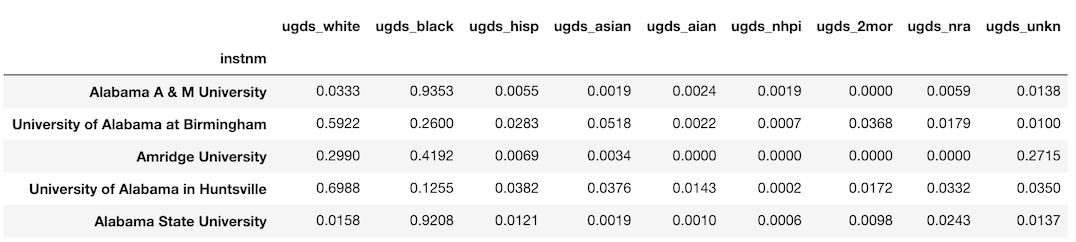

college データセットには、学部生の人種の相対頻度である連続値の列が9つ含まれています。

ugds_whiteからugds_unknまでです。

これらの列を新たな DataFrame に取り出しましょう。>>> college_race = college_idx.loc[:, ‘ugds_white’:’ugds_unkn’] >>> college_race.head()学校ごとに人種別の生徒数に関心があるとしましょう。

学部全体の人口に各列を掛ける必要があります。

Series としてugds列を選択しましょう。>>> ugds = college_idx['ugds'] >>> ugds.head() instnm Alabama A & M University 4206.0 University of Alabama at Birmingham 11383.0 Amridge University 291.0 University of Alabama in Huntsville 5451.0 Alabama State University 4811.0 Name: ugds, dtype: float64そして、先程の

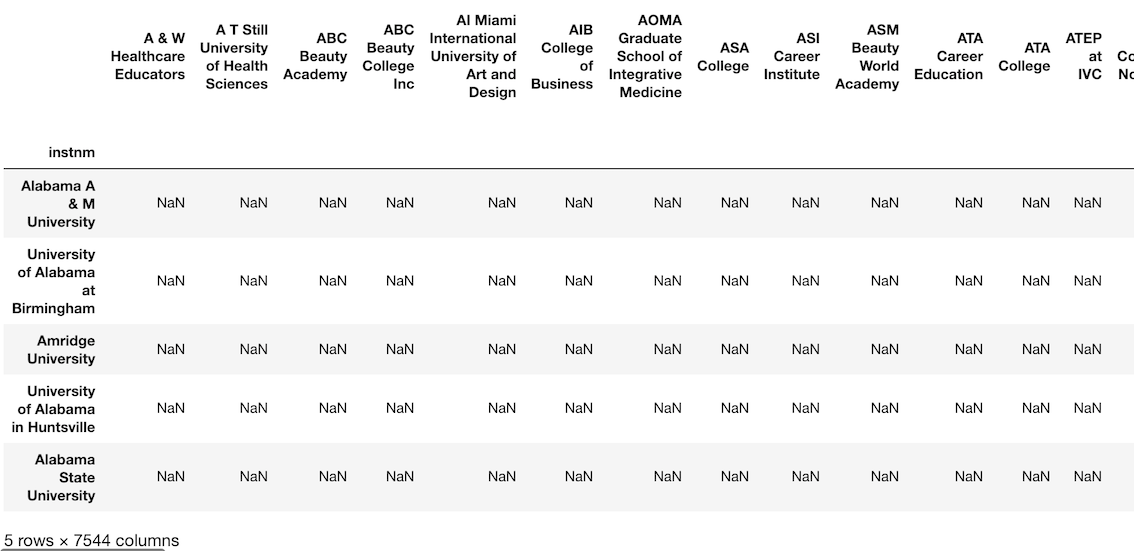

college_raceにこの Series を掛けます。

直感的にはこれでうまくいきそうですが、そう上手くはいきません。

代わりに、7544列の巨大な DataFrame になります。>>> df_attempt = college_race * ugds >>> df_attempt.head()df_attempt.shape

(7535, 7544)

```インデックス あるいは 列の自動調整

Pandas のオブジェクト同士の計算は常に、互いのインデックスあるいは列の間で調整が行われます。

上記の操作では、college_race(DataFrame) とugds(Series) を掛け合わせました。

Pandasは自動的に(そして暗黙的に)college_raceの列をugdsのインデックスの値に揃えました。

college_race列の値はどれもugdsのインデックス値と一致していません。

Pandasは、一致するかどうかに関わらず、 outer join することによって調整します。

結果は、全ての値が欠損値である馬鹿げた DataFrame になります.

college_raceDataFrameの元の列名を表示するには、右端までスクロールします。メソッドを使うことで調整の方向を変更する

全ての演算子の機能は単一であり、乗算演算子

*の機能を私達が変更することは出来ません。

一方メソッドは、パラメータによって操作を制御できるようにすることが出来ます。

mulメソッドのaxisパラメータを使います上記で述べた演算子に対応する全てのメソッドには、計算の方向を変更できる

axisパラメータがあります。

DataFrame の列を Series のインデックスに合わせる代わりに、DataFrame のインデックスを Series のインデックスに合わせることができます。

今からやり方をお見せしましょう。>>> df_correct = college_race.mul(ugds, axis='index').round(0) >>> df_correct.head()

axisパラメータのデフォルト値は columns に設定されています。

適切な調整が行われるように、それを index に変更しました。ガイダンス:どうしても必要なときだけ算術/比較メソッドを使い、そうでなければ演算子を使う

算術演算子と比較演算子の方がより一般的であり、こちらを最初に試しましょう。

どうしても演算子では解決できない場合に限り、同等のメソッドを使用しましょう。Python 組み込み関数と同名のPandas のメソッド

Python のビルトイン関数と同じ名前、同じ結果を返す DataFrame / Series のメソッドがいくつかあります。これらです:

- sum

- min

- max

- abs

1列のデータでテストして、同じ結果が得られることを確認しましょう。

まず、学部生の人口の列ugdsから欠損値を除外します。>>> ugds = college['ugds'].dropna() >>> ugds.head() 0 4206.0 1 11383.0 2 291.0 3 5451.0 4 4811.0 Name: ugds, dtype: float64Verifying

sum>>> sum(ugds) 16200904.0 >>> ugds.sum() 16200904.0Verifying

max>>> max(ugds) 151558.0 >>> ugds.max() 151558.0Verifying

min>>> min(ugds) 0.0 >>> ugds.min() 0.0Verifying

abs>>> abs(ugds).head() 0 4206.0 1 11383.0 2 291.0 3 5451.0 4 4811.0 Name: ugds, dtype: float64 >>> ugds.abs().head() 0 4206.0 1 11383.0 2 291.0 3 5451.0 4 4811.0 Name: ugds, dtype: float64それぞれの処理時間を測ってみます

sumperformance>>> %timeit sum(ugds) 644 µs ± 80.3 µs per loop >>> %timeit -n 5 ugds.sum() 164 µs ± 81 µs per loop

maxperformance>>> %timeit -n 5 max(ugds) 717 µs ± 46.5 µs per loop >>> %timeit -n 5 ugds.max() 172 µs ± 81.9 µs per loop

minperformance>>> %timeit -n 5 min(ugds) 705 µs ± 33.6 µs per loop >>> %timeit -n 5 ugds.min() 151 µs ± 64 µs per loop

absperformance>>> %timeit -n 5 abs(ugds) 138 µs ± 32.6 µs per loop >>> %timeit -n 5 ugds.abs() 128 µs ± 12.2 µs per loop

summaxminのパフォーマンスの違い

summaxminは明確に差が出ています。

Pandas のメソッドが呼び出される時とは違い、Python 組み込み関数が呼び出されるときにはまったく異なるコードが実行されます。

sum(ugds)を呼び出すと、各値を1つずつ繰り返すための Python の forループが作成されるのと本質的に同等です。

一方、ugds.sum()を呼び出すと、Cで書かれた Pandas 内部の sumメソッドが実行され、forループで反復するよりもはるかに高速です。そこまで差が大きくない理由は、Pandas には多くのオーバーヘッドがあることです。

上記の代わりに NumPy array を使用して再度検証すると、10000要素の float の配列で、 Numpy array の sum はPython組み込みのsum関数を200倍ほど上回ります。

absでは結果に差が出ない理由abs関数と Pandasの absメソッドにパフォーマンスの違いがないことに注意してください。

これは内部でまったく同じコードが呼び出されているためです。

Python は abs関数の挙動を変更する手段を提供しており(訳注:__abs__マジックメソッドのこと)

、開発者はabs関数が呼び出されるたびに実行されるカスタムメソッドを実装することができます。

そのため、abs(ugds)と書いてもugds.abs()を呼び出すことと同等です。それらは文字通り同じです。ガイダンス:python 組み込みの同名の関数よりも、 Pandas のメソッドを使う

groupbyによる集約方法の統一集約を実行する際の

groupbyメソッドにはいくつかの書き方がありますが、コードの統一感の観点から、単一の書き方を採用することをお勧めします。groupby の3つの要素

通常、

groupbyメソッドを呼び出すときは集約を実行します。

最も一般的な使用法でしょう。

groupbyでの集約処理は、3つの要素に分解できます。

- 列のグループ化

- 列内のユニークな値の抽出

- 列の集約

- 値を集計される列。通常は数値型。

- 集約関数

- 値の集計方法(合計、最小、最大、平均、中央値など)

私の

groupbyの書き方Pandas は groupby で集約する際の書き方を何パターンか用意していますが、私は以下の書き方をしています。

df.groupby('grouping column').agg({'aggregating column': 'aggregating function'})州ごとの

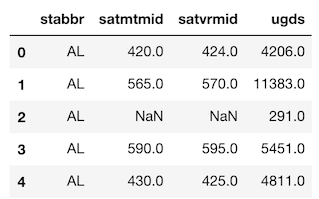

SATの最大値を算出するgroupbyの書き方のビュッフェ以下では、州ごとの最大SATスコアを見つけるために、同じ(または類似の)結果を返す、いくつかの異なる書き方について説明します。

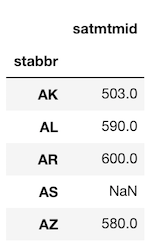

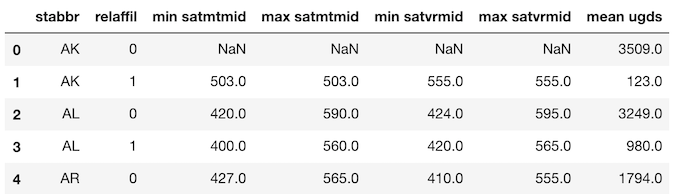

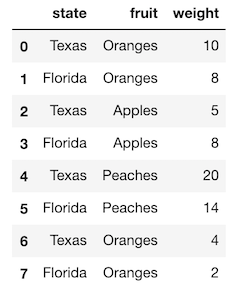

まず、使用するデータを見てみましょう。>>> college[['stabbr', 'satmtmid', 'satvrmid', 'ugds']].head()Method 1:

私の推奨する集約によるグループ化のです。複雑なケースを扱います。

>>> college.groupby('stabbr').agg({'satmtmid': 'max'}).head()Method 2a:

集約対象のカラムはブラケット記法で選択することもできます。

この場合、戻り値は DataFrame ではなく Series になることに気を付けてください。>>> college.groupby('stabbr')['satmtmid'].agg('max').head() stabbr AK 503.0 AL 590.0 AR 600.0 AS NaN AZ 580.0 Name: satmtmid, dtype: float64Method 2b:

aggのエイリアスであるaggregateメソッドを使うことも出来ます。

結果は上記と同じ Series になります。>>> college.groupby('stabbr')['satmtmid'].aggregate('max').head()Method 3:

aggメソッド経由ではなく、集約関数を直接呼ぶことも出来ます。

結果は上記と同じ Series になります。>>> college.groupby('stabbr')['satmtmid'].max().head()私の提案する方法の主な利点

この書き方だと、より複雑な集約の場合にも同じ書き方で対応できるのが、私がお勧めする理由です。

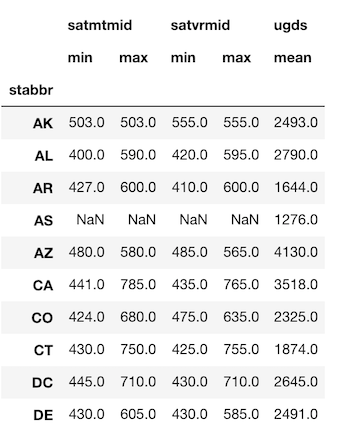

たとえば、州ごとの学部生数の平均とともに、数学と母国語の科目のSATスコアの最大値と最小値を求めたい場合は、次のようにします。>>> df.groupby('stabbr').agg({'satmtmid': ['min', 'max'], 'satvrmid': ['min', 'max'], 'ugds': 'mean'}).round(0).head(10)この手段は、他の方法では対応できません。

ガイダンス: まずは

df.groupby('grouping column').agg({'aggregating column': 'aggregating function'})方式の書き方を検討してください(訳注)dictの順序を保持しない python3.6 未満だとカラムの追加される順序が不定になるので注意

MultiIndex の扱い方

MultiIndex、またはマルチレベルインデックスは、DataFrame に追加しづらい一方、データを見やすくする事がたまにはあるもの、

しかし多くの場合、扱いがさらに難しくなります。

groupbyの集約に複数のカラムを指定している場合、あるいは複数のカラムを集約している場合は、たいていMultiIndexに遭遇するでしょう。前の章の

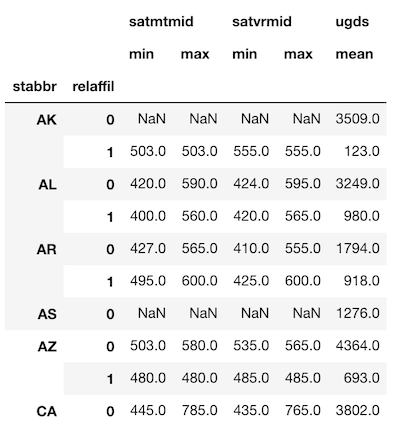

groupbyの最後のサンプルと同じ結果を作成しましょう。

ただし、今回は州と宗教の両方で集約します。>>> agg_dict = {'satmtmid': ['min', 'max'], 'satvrmid': ['min', 'max'], 'ugds': 'mean'} >>> df = college.groupby(['stabbr', 'relaffil']).agg(agg_dict) >>> df.head(10).round(0)インデックスと列が両方 MultiIndex

行と列、共に2レベルのMultiIndexになりました。

MultiIndex では、選択とさらなる処理は困難です

MultiIndex が DataFrame に追加する機能は殆どありません。

インデックスの一部を選択するための構文が異なっており、他のメソッドと共に用いるのが難しいです。

もしあなたが Pandas のエキスパートなら、インデックスの一部の選択を利用する若干のパフォーマンスが見込めるでしょうが、私は複雑さが増すことを好みません。

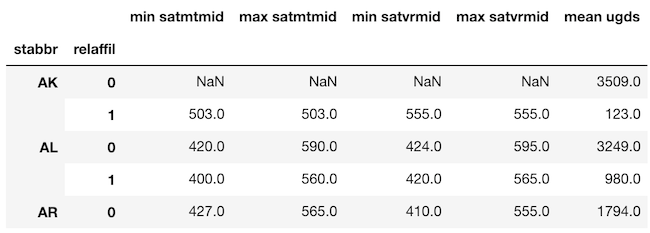

よりシンプルな、シングルインデックスの DataFrame を扱うことをお勧めします。シングルインデックスに変換 - 列名を変更してインデックスをリセットする

この DataFrame を変換して、単一のインデックスだけが残るようにしてみましょう。

groupbyの処理中に直接 DataFrame の列名を変更することはできません(そう、Pandas は非常に単純なことはできないのです)。

なので、手動で上書きする必要があります。

やってみましょう。>>> df.columns = ['min satmtmid', 'max satmtmid', 'min satvrmid', 'max satvrmid', 'mean ugds'] >>> df.head()ここから、

reset_indexメソッドを使用して、各レベルごとのインデックスを列に移動させることが出来ます。>>> df.reset_index().head()ガイダンス: MultiIndex の使用を避ける。

groupbyの呼び出し後は、列名を変更してインデックスをリセットすることによってフラット化します。

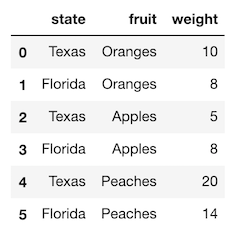

groupbypivot_tablecrosstabの類似点集約時の

groupby、pivot_table、およびpd.crosstabは本質的に同じ処理をしている、ということを知って、驚く人もいるかも知れません。ただし、それぞれに固有の使用例があるため、すべてが Minimally Sufficient Pandas に含まれるための条件を満たしています。

groupbyの集約とpivot_tableの等価性

groupbyメソッドを用いて集約をすることは、pivot_tableメソッドが行っていることと本質的には同じです。

どちらのメソッドもまったく同じデータを返しますが、shapeが異なります。

これが事実であることを証明する、簡単な例を見てみましょう。

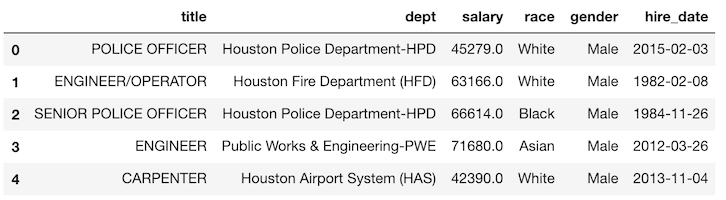

新たに、ヒューストン市の従業員の人口統計情報を含むデータセットを使用します。>>> emp = pd.read_csv('data/employee.csv') >>> emp.head()部門別の性別による平均給与を

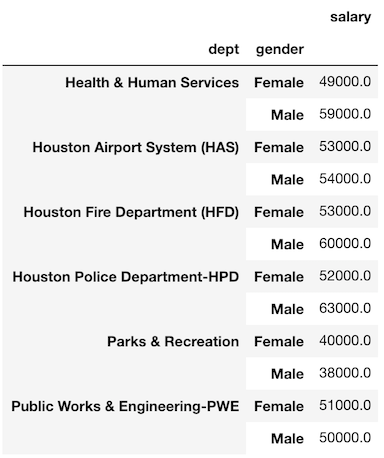

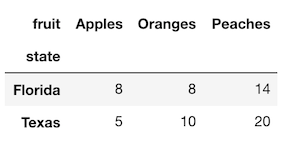

groupbyで集計してみましょう。>>> emp.groupby(['dept', 'gender']).agg({'salary':'mean'}).round(-3)

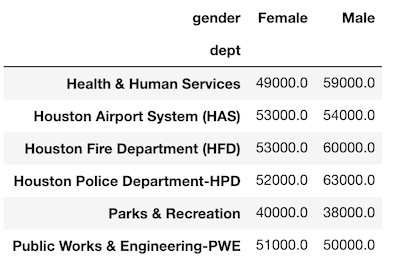

pivot_tableを使ってこのデータを複製することができます。>>> emp.pivot_table(index='dept', columns='gender', values='salary', aggfunc='mean').round(-3)値がまったく同じことに注意してください。

唯一の違いは、gender列がピボットされているため、ユニークな値が列名になっていることです。

groupbyの3要素がpivot_tableにもあります。

- 集約のキーになる列は

indexcolumnsパラメータで指定され、- 集約対象の列は

valuesパラメータに渡され、- 集計関数は

aggfuncパラメータに渡されます。両方の集約のキー列を

listとしてindexパラメーターに渡すことで、データとshapeの両方を正確に複製することが実際に可能です。>>> emp.pivot_table(index=['dept','gender'], values='salary', aggfunc='mean').round(-3)通常、

pivot_tableは2つの集約のキーを使用します。1つはインデックスとして、もう1つは列としてです。

ただし、単一の集約キー列を使用することは出来ます。

以下は、groupbyを使用して単一の集約キー列を正確に複製したものです。>>> df1 = emp.groupby('dept').agg({'salary':'mean'}).round(0) >>> df2 = emp.pivot_table(index='dept', values='salary', aggfunc='mean').round(0) >>> df1.equals(df2) Trueガイダンス: グループ間を比較する際には

pivot_tableを使う私は、グループ間で値を比較する際には

pivot_tableを好み、分析を継続したい場合はgroupbyを使用します。