- 投稿日:2019-12-21T23:55:57+09:00

新サービスに触る前に学び直す、AWSのネットワーク基礎知識まとめ

最近のAWSでは、Transit GatewayやDirect Connect Gatewayなど、ネットワークをよりシンプルに分かりやすくするための高度なネットワークサービスが増えてきました。

忙しくなってくると、ただでさえアップデートに追いつくのは大変ですが、既存のサービスの考え方を上書きするような高度なサービスが出てきたので、ワケワカラン!となる前に何とかしなければ、と不安に思っていました。ただ、これらのサービスを腹落ちして使うためには、これらのサービスが登場する以前のAWSのネットワークについて、基本的な考え方であったり、概念や知識を今一度押さえておきたいところです。

そこで一念発起して、これまでの総復習として、AWSの公式ドキュメントを読みまくり、AWSのネットワークに関する基礎知識を調べ、これらの基礎知識をさらっとおさらいできるようにまとめてみました。

最初は自分の知識整理のためだったのですが、少しずつ整理していたところ、かなりの量がまとまってきたので、公開してしまおうと思い立ちました。

気軽にスマホで1時間くらいで総復習できるようにと、できるだけ短くまとめ、簡単な表現にしています。これらの知識を総ざらいすることは、これからAWSのネットワークを学び始めたり、既存のAWSのネットワーク設計を高度化しようと考えている人だけでなく、AWS認定のネットワーク専門知識の試験対策にも良いかも知れません。

前提

- 2019年12月時点の情報です。

- AWSのネットワーク周りの基礎を振り返るためにまとめました。

- 以下の項目は入っていません。以下の項目に挑む前の知識整理と考えてまとめています。

- Transit Gateway

- Direct Connect Gateway

- Global Accelerator

1. VPC

1-1. What is VPC?

- AWS上の仮想プライベートネットワーク

- 各リージョンに配置可能

- 複数のAvailability Zone (AZ) にまたぐ (Multi-AZ) が可能

- AZは地理的に離れている

- VPC内に公開 (Public) と非公開 (Private) のネットワーク (Subnet) を配置可能

- PublicとPrivateを別のAZに配置可能

- VPCにつき1つ、インターネットへの出口 (Internet Gateway) を配置可能

- 仮想ルータ (Route Table) を複数配置可能

- SubnetごとにRoute Tableを設定可能

- Internet Gatewayへのルートがあれば、インターネットと通信可能

- VPN接続が可能

1-2. Default VPC

- リージョン毎に最初からデフォルトで存在

- リージョンに存在するAZにつき1つSubnetが存在

- Default VPCであるかどうかはマネジメントコンソールの属性を見れば分かる

- Subnetに作成したEC2には自動的にPublic IPが割り当てられる設定 (Auto-assign public IPv4がYes)

- Internet Gatewayはデフォルトで存在

- Route Tableのデフォルトゲートウェイ(0.0.0.0/0)はInternet Gateway

- Network ACLは全てのトラフィックを許可する設定

- Default VPCは削除可能

- Default VPCは1ボタンで再作成可能

- Subnet、Internet Gateway等Default VPCにデフォルトで含まれる全てのものを再作成可能

1-3. Custom VPC

- リージョンを選んで独自の設定でVPCを作成可能

- Launch VPC Wizardを使うと、4つのパターンから、Subnetも含まれている状態で、自動的にVPCを作成可能

- 通常はVPCだけ作成

- VPC作成時にTenancyを選択可能

- Defaultはアカウントを跨いだ共有領域に作成され、Dedicatedはアカウント専用領域に作成

- VPCを作成するとデフォルトでMain Network ACLとMain Route Tableが作成される

- Main Network ACLはInbound/Outbound共に全てのトラフィックが許可

- Main Route Tableでは、VPCにあるSubnet間であれば通信を許可 (local)

- VPC内にSubnetを作成可能

- SubnetのネットワークアドレスはVPCのサブセット

- AZをプルダウンで選択可能

- Subnetを作成するとデフォルトでMain Network ACLとMain Route Tableがアタッチされる

- 新しくNetwork ACLを作成してMain Network ACLと置換可能

- 新しくRoute Tableを作成してRoute Tableと置換可能

- Subnet作成直後は、Auto-assign public IPv4がNo

- Yesに変更すると、EC2構築時にPublic IPを自動アサイン可能

- Private SubnetではNoのままにしておく

1-4. VPC Limits

- リージョン毎に作成できるVPCは5個まで

- 100個まで引き上げ可能

- VPC内のSubnetは200個まで

- Elastic IPは5個まで

- Network ACLは200個、ルールは20個まで

- Route tableは200個、ルートは50個、BGPルートは100個まで

- Security Groupは2500個、ルールはInbound/Outboundで各60個、Network Interface (ENI) 毎のSecurity Groupは5個まで

1-5. Data Transfer Costs

- Data Transfer Guideが分かりやすい (価格はUS基準で記載)

- Direct Connect経由とInternet Gateway経由はInが無料、Outに課金

- Direct Connectの方がOutが安い傾向

- ロードバランサとインターネットの間の通信コストはIn/Outともに課金

- EC2とロードバランサ間の通信コストは、同じAZなら無料、異なるAZではEC2→ロードバランサに課金

- ALBとCLBでは、ALBの方が通信コストが安い

- CloudFrontからオリジンへの通信 (Out) に課金、CloudFrontへの通信 (In) は無料

- AZを跨いだEC2間の通信は、In/Outともに課金 (In/Out同時課金)

- VPC Peeringを挟んだEC2間の通信も、In/Outともに課金 (In/Out同時課金)

- リージョンを跨いだEC2間の通信は、Out側のみ課金され、Inは課金されない

- EC2同士、またEC2とRDS/RedShift/ElastiCache間の通信は同一AZでは無料

- AZを跨いだ場合、In/Outともに課金

- EC2間の通信がインターネット経由(Public IP等)となった場合、In/Outともに課金

- NAT Gatewayは、起動時間と通信データ量に応じて課金

- 起動時間ごとに課金

- NAT Gatewayを1GB通過する度に課金

- NAT Gatewayの通信データ量の課金は、EC2の通信データ量の課金と同じ

- AZを跨いだ場合に課金される点が重要

2. Subnet & Routing

2-1. Route Table

- Main Route Tableには、VPC内のいずれのSubnetとも通信できるlocalルールがデフォルトで存在

- Subnet毎にCustom Route Tableを作成してアタッチ可能

- デフォルトゲートウェイ(0.0.0.0/0)をInternet Gatewayとするルートを追加すれば、直接インターネットと通信可能 = Public Subnet

- デフォルトゲートウェイ(0.0.0.0/0)をNAT Gatewayとするルートを追加すれば、NAT Gateway経由でインターネットと通信可能 = Private Subnet

- Custom Route Tableの作成はNameタグとVPCを指定するだけ

- Route Tableを作成後にSubnetをアサイン

- Route Tableを作成後にルートを追加

- Targetが各種ゲートウェイやNetwork Interface (ENI) の場合、プルダウンでIDを選択可能

- Main Route Tableであるかどうかは属性で確認可能

2-2. Reserved IP Address

- SubnetのIPアドレスは先頭の4アドレスと最後の1アドレスが予約されている

- サブネットの1番目のアドレスがネットワークアドレス

- サブネットの2番目のアドレスがデフォルトVPCルータ

- サブネットの3番目のアドレスがデフォルトDNSサーバ

- サブネットの4番目のアドレスは将来のための予約アドレス

- サブネットの最後のアドレスはブロードキャストアドレス

2-3. Dual-Homed Instance

- 同じVPCの複数のSubnetに属するEC2のこと

- 例えばPublic SubnetとPrivate Subnetの両方に属し、両方のENIを持つ

- ENIはSubnet毎に存在し、Security GroupはENI毎に存在

- Elastic IP/Public IPは、Public SubnetのENIにアタッチ

- 通信ログを追う場合、VPC Flow LogsでENI毎にフィルタして分析できるため、ENIがPublicとPrivateで分かれていると分析が容易になる

2-4. Internet Gateway

- EC2がインターネットに通信する時、Internet Gatewayを通過する時にソースIPアドレスがPrivate IP→Public IP/Elastic IPにNATされる

- Internet GatewayはVPCのマネジメントコンソールから作成可能

- VPCを指定して作成し、VPCにアタッチして使用する

2-5. Public Subnet/Private Subnet

- Public Subnetの特徴は以下の通り

- Route TableのデフォルトゲートウェイがInternet Gateway

- (広義) Auto-assign public IPv4 addressがYes

2-6. VPC Addressing

- VPCに複数のIPv4 CIDRをアサイン可能だが、最初にアサインしたCIDRは削除できない

- VPCにアサインできるIPv6 CIDRは1個まで

- 既存のSubnetにIPv6 CIDRを追加できるが、VPCにアサインしたサイズをそのまま追加

3. EC2 in VPC

3-1. Creating EC2

- VPC、Subnet、Auto-assign Public IPを指定

- Auto-assign Public IPを指定すると、Public IPがアサインされてEC2が起動される

- ENIを設定

- Security Groupを新たに作成してアタッチ可能

- OSを操作するためにSSHを許可する

- OS内部ではPublic IPは見えない

- Public IPはEC2をStopするとリリースされ、次にStartした時に新しいPublic IPが割り当てられる

3-2. Elastic IP

- Elastic IPアドレスは、EC2をStopしても削除されず固定される

- マネジメントコンソールで作成可能

- 作成後、InstanceまたはNetwork Interfaceを指定するとアサイン可能

- 不要になればEC2からデタッチして削除する

3-3. Elastic Network Instance (ENI)

- EC2は作成直後にeth0の1個だけENIを持つ

- ENIはマネジメントコンソールから新たに作成可能

- 作成したENIをEC2にアタッチするとeth1ができる

- 以降eth2、eth3…

- ENI毎にSecurity Groupが異なるため注意

- この方法でPublic SubnetとPrivate Subnetの両方のENIを持つEC2などを作成可能

- 不要になればeth1以降のENIはデタッチして削除可能

3-4. Bastion Host

- 踏み台のこと

- まずは踏み台にSSH/RDPをして、他のサーバへのSSH/RDPは踏み台経由に限定するのがセキュア

- 踏み台のみがPublic IP/Elastic IPを持ち、他はPrivate IPのみ持つようにする

3-5. Enhanced Networking

- ネットワーク仮想化

- EC2 (仮想マシン) は物理ホスト上で稼働

- その物理ホストに仮想スイッチが存在

- ハイパーバイザーを介して無数のEC2が仮想スイッチを共有

- SR-IOV

- EC2のENIが、直接物理ホストのネットワークアダプタに接続

- SR-IOVに対応したEC2インスタンスタイプは限られる

- 対応表を見て正しいドライバをインストールすること

- ENAは最大100Gbpsをサポート

- Intel VFは最大10Gbpsをサポート

- ネットワーク性能はインスタンスタイプによるので要確認

- ドライバのロード状況はOS内部で確認可能

- 対応するためにカーネルのアップデート、バッケージのアップデートが必要なケースあり

3-6. Placement Group

- 同じAZの中には複数のデータセンタがあり、さらにデータセンタ内には複数の物理ホストがある

- 通常、EC2を構築する時、どこのデータセンタと物理ホストが選ばれるかを制御できない

- Placement Groupで、全てのEC2の配置をある程度コントロールすることが可能

- EC2初期構築時に、Placement Groupを指定して構築

- 同じインスタンスタイプを一貫して使用する方が高速化

- 後からEC2を追加できない可能性もあり

- 既存のEC2は追加できない

- Placement Groupでは、シングルフローのトラフィックが5Gbpsから10Gbps

Cluster Placement Group

- 単一AZ

- 同一リージョン内でVPC Peering経由でVPCをまたぐことが可能

- 10Gbps

- 低遅延で、ノンブロッキング、ノンオーバーサブスクライブ

- キャパシティエラーが出た場合、対応するには全てのEC2をStop→Startする必要がある

Partition Placement Group

- 単一AZ内で複数のパーティション

- 各パーティションが異なるラックに配置

- ワークロードを隔離したり複製する場合に有効

- 各AZにパーティションを持てる

Spread Placement Group

- 同一リージョンのAZにまたがって配置可能

- 全てのインスタンスを異なる電源/ネットワークを持つラックに配置

- 少数の重要なインスタンスを分散させる場合に有効

- 1グループあたり7インスタンスまで

3-7. EC2 Instance Metadata

- EC2インスタンスから http://169.254.169.254/latest/meta-data にアクセスするとメタデータを得る

- メタデータへの接続はSecurity GroupとNetwork ACLでフィルタできない

- OSの外側かつSecurity Groupの内部にあると考える

- OSのファイアウォール機能を使えば接続を遮断可能

- Proxyを経由してアクセスできないため、Proxyの設定からは除外する

- NO_PROXYを設定

3-8. AWS Config

- AWS Configのマネージドルールを活用すれば、VPCのコストを最適化できる

- eip-attached

- Elastic IPがEC2にアタッチされているか確認する

- Elastic IPはEC2にアタッチされていないと課金されてしまう

4. Network Address Translation

4-1. NAT Instance

- Public SubnetはデフォルトゲートウェイがInternet Gateway

- NAT InstanceはPrivate SubnetのEC2にインターネット接続を提供

- Public SubnetにNAT Instanceを起動

- Private SubnetのデフォルトゲートウェイをNAT Instanceに指定

- NAT Instanceは手動でスケールしたり、フェールオーバーのための仕組みが必要

- NAT InstanceのSource/Destination Checkを無効にしないと通信できない

- SourceまたはDestinationがNAT Instanceにはならないトラフィックを、NAT Instanceで送受信するため

4-2. NAT Gateway

- NAT Instanceの代わりにNAT Gatewayを採用

- Private SubnetのデフォルトゲートウェイをNAT Gatewayに指定

- 利点

- EC2が不要

- 完全マネージドサービスでスケールやパッチの管理が不要

- 複数AZに跨いで構築可能

- 複数NAT Gatewayを同一AZに構築可能

- 欠点

- 踏み台にはならない (NAT Instanceは踏み台としても使える)

- ポートフォワーディングを手動で設定できない

- セキュリティグループを割り当てることができない

- NAT GatewayはVPCのマネジメントコンソールから作成可能

- Subnetを指定し、Elastic IPを紐付けて作成

- Elastic IPを新たに作成も可能

- NAT Gatewayの制限と特徴

- 必ず1つの特定のAZに属する

- 5Gbpsの帯域をサポートし、45Gbpsまで自動的にスケールアップする

- Elastic IPを外すことはできない

- Security Groupは適用できない

- 1024-65535ポートを使用するため、Network ACLを開放する

- 送信先別に最大55000の同時接続をサポート

- 単一の送信先に1秒あたり約900の接続

- 送信先IPアドレス、送信先ポート、またはプロトコル (TCP/UDP/ICMP) が変更された場合は、追加の55000の接続を作成可能

5. VPC Peering

5-1. What is VPC Peering?

- 同じアカウントまたは異なるアカウントにある2つのVPCを接続するための機能

- VPC AからVPC Bに接続リクエストし、VPC Bが承認すれば接続

- VPC AとVPC BでIPアドレスの重複は不可

- 接続先VPCのネットワークアドレス宛のTargetをVPC Peering(pcx-…)にするルートを、Route tableに追加

- VPC 1、 VPC 2、VPC 3とあって、1-3と3-2がつながっている構成の場合

- 1と2は直接接続できない

- 1と2でPeeringすれば接続可能

- アカウントとVPCが増えるほど、トポロジーは複雑となる

5-2. VPC Peering Design

- 3つ以上のVPCがあり、共有VPCを作る場合

- 共有VPCと直接的に接続するVPC CIDRは、互いにユニークであること

- 例えば共有-A、共有-Bという構成の場合、共有とA、共有とBのCIDRは重複不可

- ただしAとBのVPCはCIDRが重複して良い

- 共有VPCのRoute Tableで宛先が特定されており、Targetが分かれていれば良い

- 共有VPCに2つSubnetがあり、各サブネットのSubnetのRoute TableでTargetが分かれていてもOK

5-3. Overlapping CIDR

- 例: VPC1-VPC2(共有VPC)-VPC3という構成

- VPC1とVPC3のCIDRが重複

- VPC1-VPC2、VPC1-VPC3のCIDRはユニーク

- VPC1とVPC3に同じIPアドレスのEC2が構築されている

- VPC2にEC2が2台あり、片方はVPC1、もう片方はVPC3と通信したい場合

- VPC1のSubnetと、VPC2のSubnetのCIDRを分けれは解決できる

- VPC1とVPC3の各EC2を、作成したSubnetに移動する

- VPC2では各SubnetのCIDRに応じてTargetを分ける

5-4. VPC Peering Connection

- リクエスタのVPCと、アクセプタのVPCを指定して作成する

- リクエストが送られてPendingとなり、リクエストがAcceptされると接続される

5-5. DNS for VPC Peering

- VPC Peeringの設定で、アクセプタVPCのホスト名をPrivate IPに解決するようにDNSの設定を追加可能

- この設定が有効になると、例えばアクセプタVPCのPublicホスト名をルックアップすると、プライベートIPアドレスが返るようになる

- 逆方向の設定も可能

5-6. Delete VPC Peering

- VPC Peeringを削除しても、Route Tableのルールは自動で消えず、Blackholeとなる

5-7. Costs of VPC Peering

- In/Outの両方に課金される

6. VPC Security and Monitoring

6-1. Security Group

- ステートフルなファイアウォール

- Inboundルールがあれば、対応するOutboundルールは不要

- ENIあたり最大5個

- Inboundはデフォルトで全拒否、Outboundはデフォルトで全許可

- Outboundのデフォルト全許可ルールは削除が可能

- 許可ルールのみ設定する

- EC2毎に異なるSecurity Groupをアタッチするのが王道

- EC2のIPアドレスではなく、Security GroupのIDを指定してアクセス許可が可能

6-2. Security Group vs Network ACL

- ENIに複数のSecurity Groupをアタッチ可能

- 後からでもSecuriuty Groupのアタッチ状況を変更可能

- Network ACLはステートレスファイアウォール

- Inboundルールに対応するOutboundルールが必要

- ルール番号が若い順に評価

- 宛先やポートを特定してDENYするルールは、ALLOWよりも先に入れるのがベストプラクティス

- Network ACLは、作成直後のデフォルトが全拒否

- ルール番号が*のルールは削除できない

- 外部からアクセスがあると、まずNetwork ACLが判定され、パスするとSecurity Groupが判定される

- EC2インスタンスのメタデータへのアクセス制限

- Security Groupでは制限できない (SGよりも内側にあると考えるべき)

- メタデータへのアクセスはOSのファイアウォールで保護する

6-3. Virtual Private Gateway

- リージョン毎に5個まで

- VPCにアタッチして使用

- デフォルトで高可用性がある

- オンプレミスのデータセンタとVPN Connectionで接続

- オンプレミス→VPC

- Next HopをVPN Routerに向ける

- ルートの伝播

- VGWからRoute TableにBGP routeが自動で追加される

- 最も具体的なプレフィックスが優先される

- 手動で設定されたルートが優先される

- ローカルのルートが優先される

6-4. VPC Endpoint

- S3とDynamo DBにプライベートアクセス

- Gateway型エンドポイントと呼ばれる

- 通常、Internet Gateway経由で接続する

- Private SubnetではNAT経由

- VPC Endpointがあると、Private SubnetからGatewayを通り直接アクセス

- Route Tableには「pl-…」宛の通信がGatewayを向くようにルートが設定される

- リージョン毎に存在

- 1つのVPCに対して1つのGatewayが紐づく

- VPC Peering経由、VPN Connection経由では接続不可

- VPC内でPublicアドレスをPrivateなEndpointアドレスに解決することが必要

- Endpointポリシーで、IAMポリシーのようにアクセス制御が可能

6-5. AWS WAF

- AWS MarketPlaceではサードパーティ製WAFアプライアンスを購入可能

- WAFサンドイッチ

- WAFをスケールするためにAutoScalingポリシー下で実行する

- 2つのロードバランサ (ELB) 間に配置

- AWS WAF

- CloudFrontまたはELBにデプロイ可能

- SQLインジェクションやクロスサイトスクリプティングなどに対応するマネージドルール

- APIでコントロール可能

- CloudFrontでコンテンツのアクセス制限をかける方法

- オリジンアクセスアイデンティティを使用

- AWS WAFのIPホワイトリストを適用してアクセス制限

6-6. VPC Flow Logs

- VPCのネットワークログ

- CloudWatch Logsに保管

- VPC、Subnet、EC2 (ENI) で作成可能

- accepted、rejected、allを選んで記録可能

- 10分毎にログが公開される

- VPC Flow Logs用のIAM Roleが必要

- VPC Flow Logsサービスとの信頼関係も必要

- ログではENI、Source、Destination、Source Port、Destination portを判断可能

- Flow Logsは作成後に変更できない

- AWS DNSサーバへのトラフィックは記録されない

- Windowsライセンス認証のためのAWSライセンスサーバへのトラフィックは記録されない

- DHCPトラフィックは記録されない

- 予約されたデフォルトVPCルータへのトラフィックは記録されない

- インスタンスメタデータへのトラフィックは記録されない

- リアルタイムには記録されない

- CloudWatch Logsに出力するためにIAM Roleが必要

- ENIごとにログストリームができる

6-7. Analyze Firewall Rules

6-8. Proxy

- EC2からのインターネット接続にホストベースのアクセス制限をかけるにはProxy EC2が必須

- 可用性を持たせるには複数AZにまたぎ、ロードバランサと併用を検討する

6-9. Deep Packet Inspection

- 通常とは異なるトラフィックを検知して分析

- AWS MarketPlaceでサードパーティ製アプライアンスを購入することで、多くの場合分析が可能

- モニタリングはCloudWatch、CloudWatch Logs、VPC Flow Logsでも可能

7. Elastic Load Balancer

7-1. What is ELB?

- EC2インスタンスのトラフィックを負荷分散

- 複数のAZに存在するインスタンスに負荷分散可能

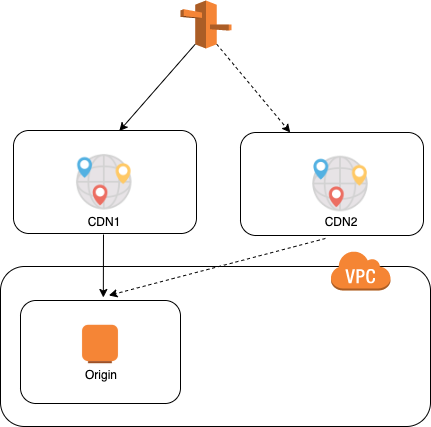

- リージョンをまたぐには複数ELBを用意してRoute53を併用

- ELBはALB、NLB、CLBの3種類

- ヘルスチェック機能があり、応答しないEC2インスタンスにはリクエストを送らない

- Internet-Facing ELB

- Route53でPublicホスト名をエイリアスレコードで解決

- Securuty GroupをELBにアタッチしてアクセス制御可能

- マネジメントコンソールからELBの種類を選択して作成

- さらに分散するAZと、ターゲットにするEC2を選択

7-2. Listener and Encryption

- HTTP/HTTPSリスナー

- port 1-65535でHTTPまたはHTTPSをサポート

- HTTPSリスナーは暗号化と復号化をELBにオフロード

- HTTPSはX.509 SSL証明書のデプロイが必要

- AWS Certificate Managerがデプロイに使える

- サードパーティー証明のためにCSRが必要

- 複数の証明書を、複数のドメインに利用

- Fixed-Response Actions

- 特定のターゲットグループにリクエストをforward可能 (リダイレクト)

7-3. Target Group

- TargetのTypeにEC2インスタンス、IPアドレス

- ALBの背後にLambdaを配置可能

- 同じインスタンスで複数のポートをTargetに指定可能

- slow_start.duaration_seconds

- 新しく登録されたターゲットに対しトラフィックをリニアに増やすよう、時間を指定

- スティッキーセッション

- Cookieを利用して同じターゲットと通信

7-4. Host Condition/Path Condition

- Host Conditions

- example.com (APEXの例)

- dev.example.com (特定ホストの例)

- test.example.com (特定ホストの例)

- *.example.com (ワイルドカードの例)

- example.com以外のトラフィックを指す

- Path Conditions

- /img/*

- /js/*

- .example.com/img/

7-5. Connection Draining

- ELBから登録解除したり、ヘルスチェック失敗したインスタンスへのリクエストを止める

- 止めつつも、処理中のリクエストはそのまま処理を続ける

- 期間は1秒から3600秒まで

- Auto ScalingはConnection Drainingを待つ

- 簡単に有効/無効を切り替えられる

7-6. X-Forwarded

- EC2から見るとELBのプライベートアドレスから全てのリクエストが来たように見える

- 本当はELBの前にいるクライアントのIPアドレスが知りたい場合が多い

- リクエストヘッダのX-Forwardedを見ればクライアントのIPアドレスが分かる

- ALB、CLBでサポート

- 有効/無効の特別な操作は不要

8. DNS with Route 53

8-1. Route 53

- DNSレコードの種類

- A: IPv4 IPアドレス

- AAAA: IPv6 IPアドレス

- CNAME: 別ホスト名 (APEXは指定不可)

- MX: Eメール

- NS: 別のネームサーバ

- Route 53

- AWSのDNSサービス

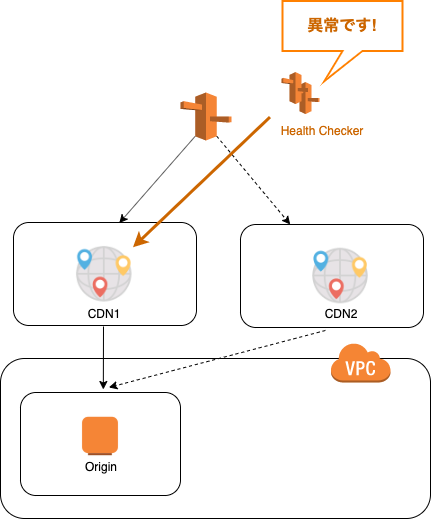

- エンドポイントのヘルスチェックに対応

- DNSは53番ポートで稼働

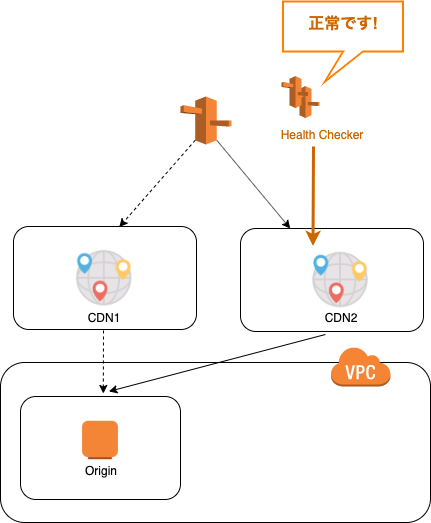

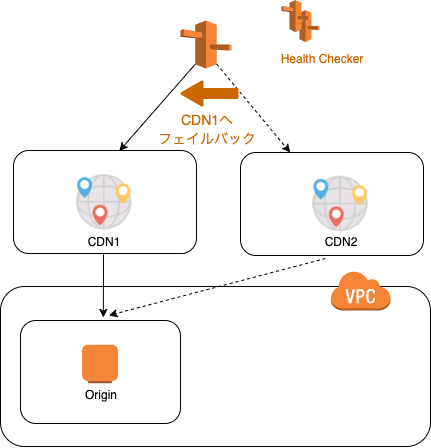

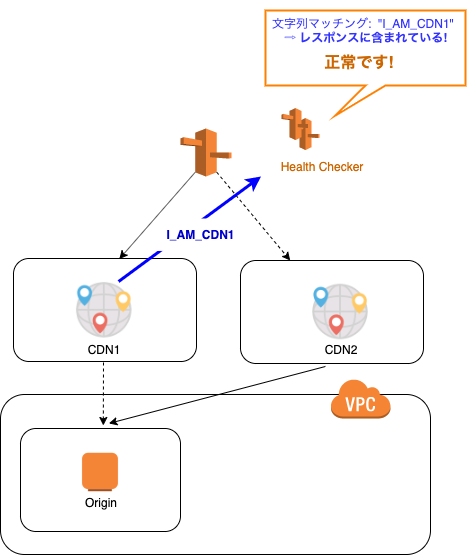

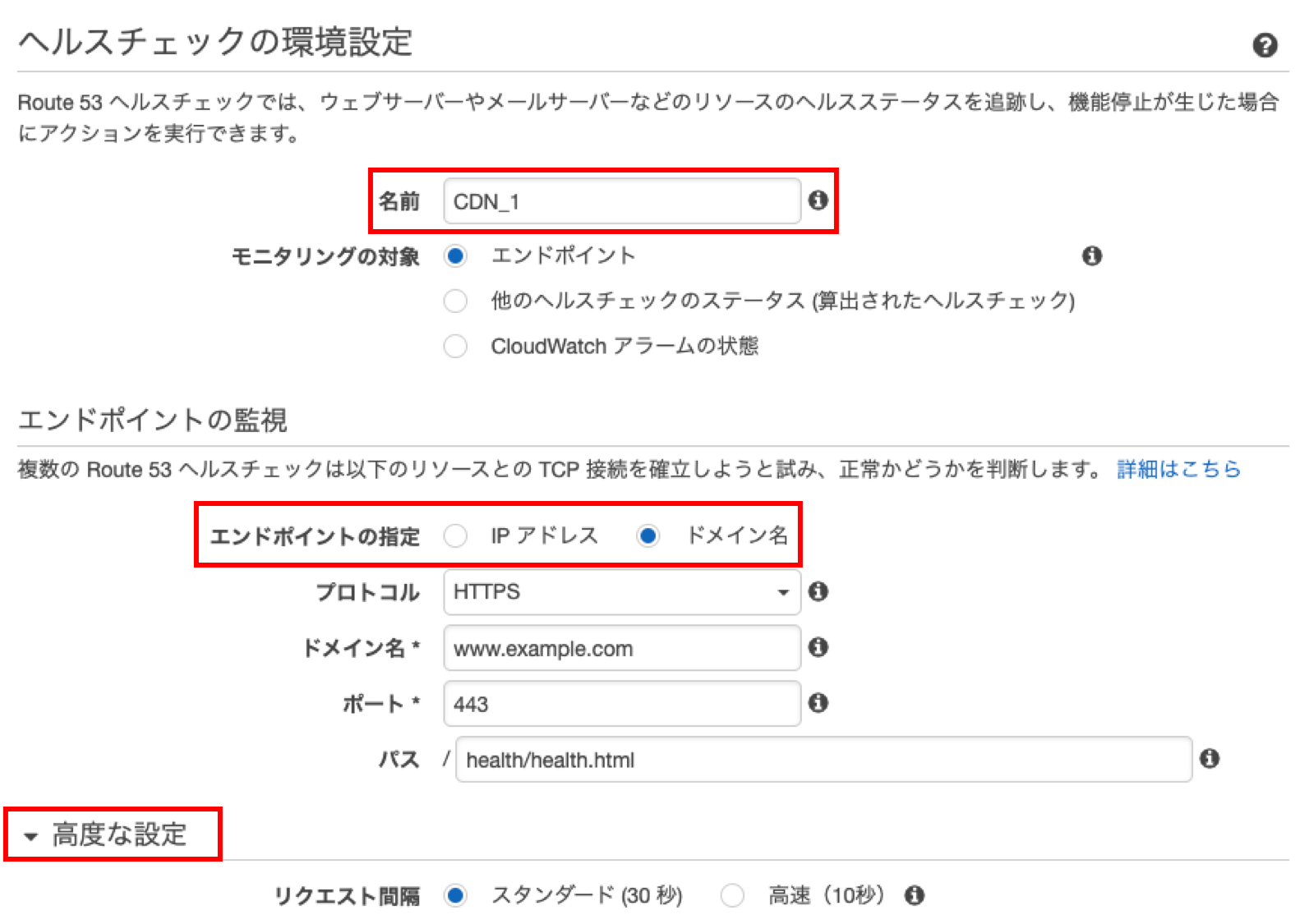

- Route53 Health Check

- 間隔は調整可能

- システムが冗長構成を取る場合に使える

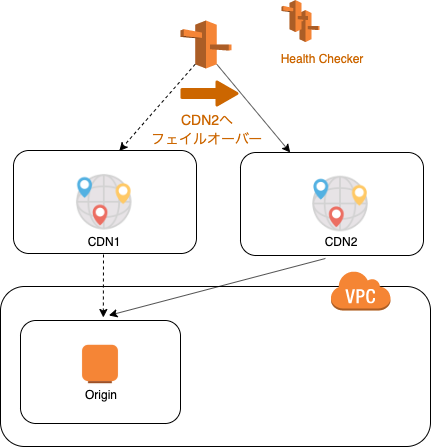

- Weighted Routing Policy

- ホスト名に複数IPアドレスを紐付けておき、例えばWeb1に90%、Web2に10%などの重み付けをしてリクエストを振り分け

- Latency-Based Routing Policy

- ホスト名に複数IPアドレスを紐付けておき、レイテンシに基づいて振り分け

- Failover Routing Policy

- ホスト名に複数IPアドレスを紐付けておき、通常はActive EC2インスタンスにリクエストを振り分け

- ヘルスチェックに失敗する場合には、Standby EC2にリクエストを振り分ける

- ELBは複数のリージョンを跨いでリクエストを振り分けられず、リージョン跨ぎはRoute 53の出番

- GeoLocation Routing

- リクエスタの地理的位置に基づいてリクエストを振り分け

- Alias Record

- CNAMEによく似ている

- ELBにAPEXレコードを紐付けるのに使える

8-2. Register Domains on Route 53

- マネジメントコンソールで可能

- 登録後、レコードセットが編集可能に

8-3. Simple Routing Policy

- AレコードでALIASレコードを登録するには、Aliasにチェック入れる

- ELBの場合は、TargetにELBのホスト名を入れる

- APEXにALIASを入れる場合、解決したいホスト名は空欄にする

- AレコードでALIASを使わない場合、ValueにIPアドレスを入力する

8-4. Weighted Routing Policy

- 同じホスト名に複数のターゲットを紐付け、割合を設定すれば良い

- 動作確認は、クライアントのキャッシュを削除しながら実施

8-5. Latency-Based Routing Policy

- 同じホスト名に複数のターゲットを紐付け、低レイテンシの方に振り分けられる

8-6. Failover Routing Policy

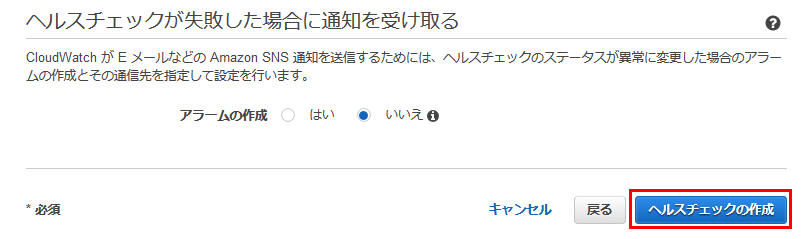

- ヘルスチェックを設定する

- エンドポイントをモニターする設定にして、モニターするIPアドレスを指定すると、グローバルIP単位で監視可能

- ドメイン名をモニターする設定にすれば、Webサイト全体の監視可能

- 同じホスト名に複数のターゲットを紐付け、片方をPrimary、もう片方をSecondaryにする

- Primaryの方に、発動条件となるヘルスチェックを紐付ける

- Primaryに紐付けたヘルスチェックが発動すると、リクエストはSecondaryに振り分けられる

- PrimaryとSecondaryの両方がダウンすれば、もちろん接続できない

8-7. GeoLocation Routing Policy

- レコードに対してロケーションを指定

- 指定したロケーションに近い位置からのリクエストの場合、当該レコードで解決

8-8. Private Hosted Zone

- インターネット経由で解決するホスト名はPublic Hosted Zoneで解決

- プライベートネットワークでしか使わないホスト名はPrivate Hosted Zoneで解決

- Hosted Zoneを作る時にPrivateを選択すれば作成可能

- 複数のVPCを1つのZoneに割り当て、複数のVPCでZoneを共有

8-9. Hybrid DNS

- オンプレミスにDNSがあるとき、VPCにRoute 53 DNS Resolverを作って、オンプレミスからフォワードすることが可能

- Inbound Endpointを作れば良い

8-10. Route53 Alias Record for CloudFront

- 地理的に一番近いEdge locationにリクエストが割り振られる

9. CloudFront

9-1. What is CloudFront?

- CDN

- 例えばS3に置いてあるコンテンツを世界中に公開したいとき

- レイテンシが問題となる

- CloudFrontを使えばコンテンツのキャッシュを世界各地のエッジロケーションにばら撒ける

- 各地のユーザは一番近いエッジロケーションからコンテンツを受信するため低レイテンシとなる

- 設定したTTLが経過すると、エッジロケーションのコンテンツを最新化する

- 署名付きURLを使って、アクセス期限を設けることも可能

- セキュリティ

- AWS WAFとの併用

- AWS Certificate Manager

- オリジンアクセスアイデンティティ

- Distributionsはマネジメントコンソールで作成

- オリジンにS3、ELBまたはRoute53を指定可能

- Webディストリビューションで、シンプルなWebサイトのデータを配信

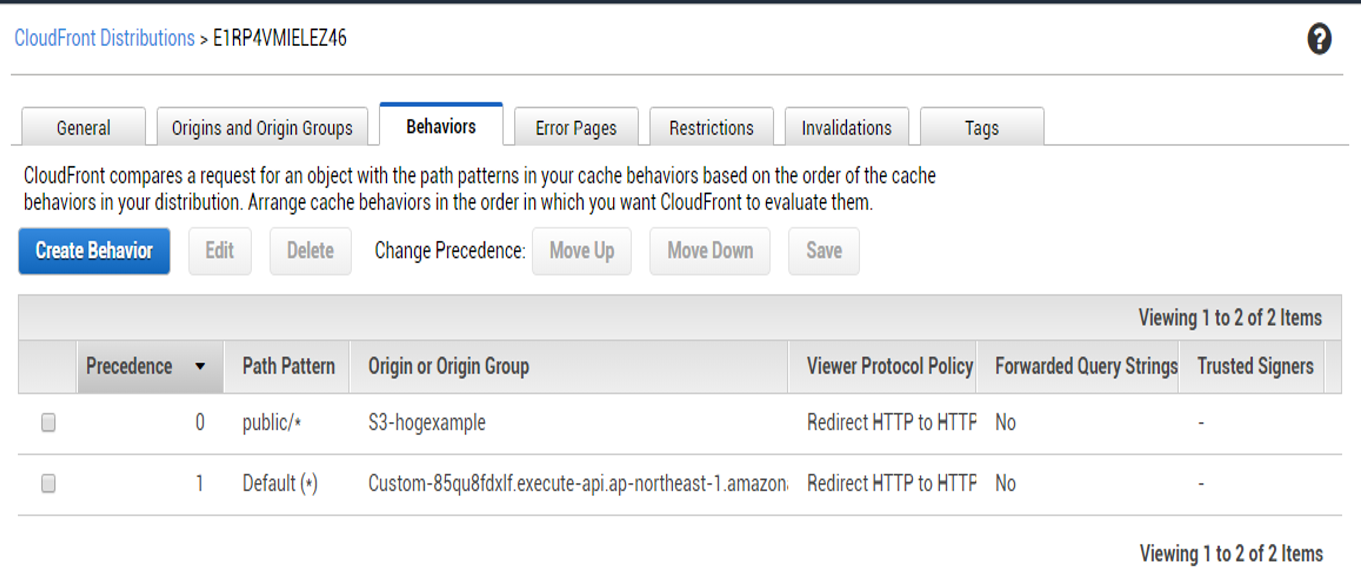

9-2. Distribution

- CloudFrontのマネジメントコンソールで、Distributionを作成

- Webを選択

- S3バケットのURLを指定

- オリジンアクセスアイデンティティに基づき、S3側でアクセス制限可能

9-3. HTTPS with CloudFront

- Viewer Protocol Policy

- Redirect HTTP to HTTPS

- HTTPS Only

- Origin Protocol Policy

- Match Viewer

10. Hybrid Cloud with Datacenter

10-1. Use Cases

- Disaster Recovery

- AWSをオンプレミスのDRサイトとして利用

- Cloud (Dynamic) Bursting

- ピーク時だけオンプレミスからAWSに拡張する

- Data Center Extension

- VPNでAWS VPCに接続し、オンプレミスのデータセンタを常時AWSに拡張

- 1つのデータセンタのように使う

- AWSはISOやPCIなどの多くのコンプライアンスを満たしたデータセンタである

10-2. Software VPN

- Public SubnetにVPN Softwareを導入したEC2を準備し、EIPを付与

- Route Tableでオンプレミス宛通信を上記EC2に向けるルートを作成

- Internet Gateway経由でオンプレミスとVPNを張る

- コンプライアンスに応じて準備できる

- EC2インスタンスを準備する必要があり、停止すれば接続断となってしまう

- 複数AZにまたがってVPN EC2を構築し、高可用性をもたせることは可能

10-3. Hardware (Managed) VPN

- オンプレミス側データセンタにVPNルータを置き、AWS VPC側のVirtual Private Gateway (VGW) との間でVPNを接続

- 設定が簡単

- 管理も不要

- 高い可用性

- DirectConnectと併用可能

- 通信データ量にかかる金額はDirectConnectの方が安い

10-4. Static Hardware VPN

- BGPがサポートされない環境ではStaticルーティング

- Customer Gateway (CGW) を作成

- Staticを選び、オンプレミスのルータのグローバルIPを指定

- VGWを作成

- VPN Connectionをオンプレミスのルータ (GGW) とVGW間で作成

- Site-to-Site VPN

- Staticを選択

- Static IP Prefixでオンプレミス側のネットワークアドレスを記入

- VPN Tunnel Optionsで169.254.0.0/16から/30でアドレス指定

- 予約されているアドレスは指定不可

- Route TableでVGWからのPropagateをONにする

- オンプレミスのルータに応じたコンフィグをダウンロードして、オンプレミス側で設定

10-5. BGP

- 各ネットワークをつなぐには、ルータ間でBGP PEERを結ぶ

- 互いのネットワークの経路情報を交換 (共有)

- Weight and AS Path

- Weight: 32768 (デフォルト)

- 同じ宛先でもWeightを変えることで優先付けが変わる

- Next HopとAS Pathを指定

10-6. BGP Hardware VPN

- VPNをAWS側の2つのエンドポイントとの間で張る

- エンドポイントは異なるハードウェアであり冗長性がある

- Customer Gateway (CGW) を作成

- Dynamicを選び、オンプレミスのルータのグローバルIPを指定

- VGWを作成

- Route TableでVGWからのPropagateをONにする

- VPN Connectionをオンプレミスのルータ (GGW) とVGW間で作成

- Dynamicを選択

- VPN Tunnel Optionsで169.254.0.0/16から/30でアドレス指定

- 予約されているアドレスは指定不可

- オンプレミスのルータに応じたコンフィグをダウンロードして、オンプレミス側で設定

10-7. VPN BGP Routing

- 構成例

- AWS側に2つのエンドポイントのグローバルIPアドレス

- 各TunnelにAWSのネットワークアドレス

- オンプレミス側ルータに1つのグローバルIPアドレス

- Tunnelの両端にTunnelネットワークアドレスからIPアドレスをアサイン

- オンプレミス側ルータの設定例

- 自身のプライベートネットワークに、Weight:32768、AS Path:i

- AWS側ネットワークアドレスに、Weight:0、AS Path:64512,i

- Next HopはTunnelの対向アドレス

- AWS側ルータは上記の逆となる

10-8. CloudHub

- 構成例

- AWS側 (ASN 64512)

- オンプレミスA (ASN 65000)

- オンプレミスB (ASN 65001)

- AWS側では、オンプレミスAとBに対するルートを持つ

- Next HopとAS Pathは適切に設定される

- オンプレミスBからAへのルート

- 宛先がオンプレミスAの時のNext HopをVGWに向ける

- AS Path: 64512,65000,i

- VGWを介してオンプレミスAとBが接続されるためCloudHubと呼ぶ

- AS番号は必ず分ける

10-9. Transit VPC

- 多くのVPCを接続するシチュエーション

- Transit VPCを作成し、中にSoftware VPNソリューション on EC2を作成

- その他多くのVPCでVGWを作成

- 全てのVGWとEC2の間でVPNを接続

- BGPで接続

- AS番号を適切に設定

- なぜVPC Peeringではだめなのか

- VPC PeeringのGatewayがNext Hopとなってしまう

10-10. Security Group over Region

- リージョンをまたいでSecurity Group IDを参照不可

- リージョンをまたぐ場合はIPアドレスレンジを指定してアクセス制御

10-11. Private EMR

- S3にデータを置く場合、S3 Endpointと併用する

10-12. Workspaces

- 異なるAZにある2つのPrivate Subnetと、1つのPublic Subnetの構成を推奨

- インターネット接続はNAT Gateway経由を推奨

- VPN経由で接続する場合1200 MTUを最低でも確保

11. Direct Connect

11-1. What is Direct Connect?

- VPC-VGW-Direct Conect location-オンプレミス

- Ditect Connect locationよりも左がAWS側のバックボーン

- VPNよりは複雑で、プロビジョニングには時間がかかる

- 冗長性を持たせるには、複数接続を作る必要あり

- 初期費用がVPNよりも高価

- ただしデータ通信量にかかる費用はVPNやInternet Gateway経由より安価

- 標準では暗号化されていない

- AWSのハードウェアVPNをDirect Connect上で利用可能

- 予測可能で低遅延なパフォーマンス

- DXと略される

- AWSサービスと接続するにはDX接続とVIFが必要

11-2. High Availability

- オンプレミスとAWSの間で高い冗長性を待たせる方法

- 一番高性能なのは、異なるDirect Connect locationを経由して2本のDirect Connectを接続すること

- 2本のDirect ConnectをVGWに接続

- オンプレミス側ルータも2台用意

- 副回線としてIPSec VPNを引くことでも冗長性を確保できる

- コストパフォーマンスはDXとVPNの併用の方が安価

11-3. Connection

- 構成

- Direct Connect locationにAWS側のDXルータと顧客のルータが配置される

- それぞれ別のラックに配置

- オンプレミス側データセンタとDirect Connect location間はWAN接続

- AWS側のDXルータとVGW間は、AWSのプライベートバックボーンで高速に接続

- 複数のVirual InterfaceとVLANを作成可能

- 設定の流れ

- Direct Connectを、AWS VGWとAWS側DXルータ間で作成するため、接続を要求

- AWSがリクエストを処理すると、Letter of Authorization and Connecting Facility Assignment (LOA-CFA) がダウンロード可能に

- メールが届くので確認

- AWSからの接続承認

- LOA-CFAはAWSマネジメントコンソールでダウンロードする

- LOA-CFAをコロケーションプロバイダと共有

- コロケーションプロバイダと連絡を取り合う必要あり

- AWS側DXルータと顧客ルータをクロスコネクト接続

- (だいたい) 5営業日以内には接続完了 ※プロバイダによる

- 以上で接続は完了

- ただし実際にAWS VPCと接続するには次項のVirtual Interface (VIF) が必要

11-4. Private Virtual Interface

- 前項までの通りDX接続が完了したらVIFを作成

- マネジメントコンソールで新しくVIFを作成

- VIFを作成すると、単一のVLANがVGWと顧客ルータの間に張られる

- VIFを作成するために必要なもの

- VGW (VIFを終端)

- 仮想インタフェースを保有するAWSアカウント

- VLAN ID

- BGP ASN

- AWS側ルータのピアIP

- オンプレミス側ルータのピアIP

- VIF作成後、オンプレミス側ルータ用の設定ファイルをダウンロード

- オンプレミス側ルータとVGWの間でBGPによる接続

- Route Tableでルート伝播を有効化する

11-5. Public Virtual Interface

- S3やDynamo DBのようなAWSサービスにDirect Connectで接続する場合にPublic VIFを使用

- VIFを作成するために必要なもの

- 仮想インタフェースを保有するAWSアカウント

- VLAN ID

- BGP ASN

- AWS側ルータのピアIP

- オンプレミス側ルータのピアIP

- VIF作成後、オンプレミス側ルータ用の設定ファイルをダウンロード

11-6. Hosted Connection

- Direct Connect locationに自社のルータを持たない場合、自社独自にクロスコネクト接続ができない

- そこでDirect Connectパートナー (日本では回線業者)の設備を利用して接続する

- 接続方法

- Direct Connectパートナーとコンタクトを取る

- 回線速度、ロケーションを指定

- ホスト型接続ではVLANは1つのみ

- VLANの設定はコントロールできない

- VIFも1つであり、接続ごとにPublic or Private

- 別のVIFが必要となった場合は、新たにホスト型接続を作る

- 通常の接続と比べると、柔軟性が劣るものの、特にDirect Connect location周りの設備投資が不要であり、必要な接続に対して利用料を支払うだけで良く、低コストとなる

12. Disaster Recovery

12-1. Tactics

- オンプレミスのリカバリサイトとしてAWSを利用する

- RPOとRTOを考える

- RTOは、どれだけの時間でシステムを復旧するか

- RPOは、いつの状態に戻せるようにするか

- リストアは定期的にリハーサルしておく

12-2. Backup and Restore

- プライマリサイトとリカバリサイトを用意する

- サーバ、ハイパーバイザー、ストレージを構成する各ハードウェアを物理的(地理的)にも分離させる

- プライマリサイトがダウンした時に、リカバリサイトで稼働を継続することを考える

- プライマリサイトがオンプレミスにある場合、リカバリサイトをAWSに配置することを考える

- ストレージのバックアップには、AWS MarketPlaceで販売されているサードパーティ製アプライアンスが使える

- CloudBerry等が候補

- オンプレミスからS3にバックアップ

- S3のライフサイクルポリシーで、バックアップをGlacierに移動すれば低コストで管理

- AWS上に新たなEC2を立て、S3からデータを復旧

- AWS上のリカバリサイト構築には手動の操作が多くなるため、すぐ起動できるようにCloudFormationを準備しておく

- AWS上のCold Standbyコストを節約

- EC2、ELB、RDS等を含み複雑な構成であってもすぐに起動できる

12-3. Pilot Light

- AWS上リカバリサイトでは、システムの重要なデータや機能 (例えばコンテンツ、RDS) だけを常にホストしておく

- コンテンツやデータベースは、AWS上に常に同期

- その他サーバ群はAMIを取り、セキュリティパッチ等を最新に維持しておく

- 災害時はAMIからEC2を起動し、コンテンツは同期していたもので置き換え、データベースは接続するだけ

- 都度の起動よりも手順を簡略化する方法としては、Auto Scaling Groupを設定して常時max=mix=0にしておき、有事に設定値を上げるのが良い

- 最後にDNSをプライマリサイトからリカバリサイトに切り替える

12-4. Warm Standby

- AWS側のリカバリサイトでも、常にプライマリサイトの構成を起動

- AWS上リカバリサイトが低コストになるように、各層のEC2は低スペックにする

- Auto Scaling Groupで起動しておくのが有効

- 有事はAuto ScalingでEC2の台数を増やしてリクエストをさばく

- データベースやコンテンツは常にプライマリサイトとリカバリサイトで同期

- 有事にはRoute 53のFailover Routingで切り替える

- プライマリサイトとリカバリサイトでは性能差が出るため、Weighted Routingをする場合は90:10など差をつける

12-5. Multi-Site

- AWS側のリカバリサイトでも常時プライマリサイトと同性能を確保し、有事でも稼働を継続する

- Active/Activeで起動する

- Route 53のWeighted Routingをプライマリサイトとセカンダリサイトで50:50にする

- AWS側のリカバリサイトをStandbyにする場合は、Failover Routingを使用

- 切替直後からフル性能を発揮できる

最後に

AWSの東京リージョンがリリースされてから約10年が経過していますが、昔からあるAWSのサービスは続々と機能がアドオンされ、高機能化してきました。

また、新たにリリースされるサービスの中には、既存のサービスをより使いやすくする目的のものもあります。

なぜ新たにリリースされたサービスが有益であるかを理解するには、既存のサービスの概念や仕組みを理解する必要があるでしょう。

ただ、10年という年月の中で積み上がった概念や仕組みはさすがに巨大であり、何も考えなければ、振り返るのは大変だと感じていました。

そこで一念発起し、後からでも長年の積み重ねを少しでも短時間で振り返ることができるように、まとめてみました。記事中にまとめた内容は、ほぼ公式サイトやホワイトペーパーを参考にしています。

万が一内容に誤りがあれば、お知らせいただければと思います。参考文献

AWS Whitepapers & Guides (※英語版の方が最新)

- 投稿日:2019-12-21T23:48:40+09:00

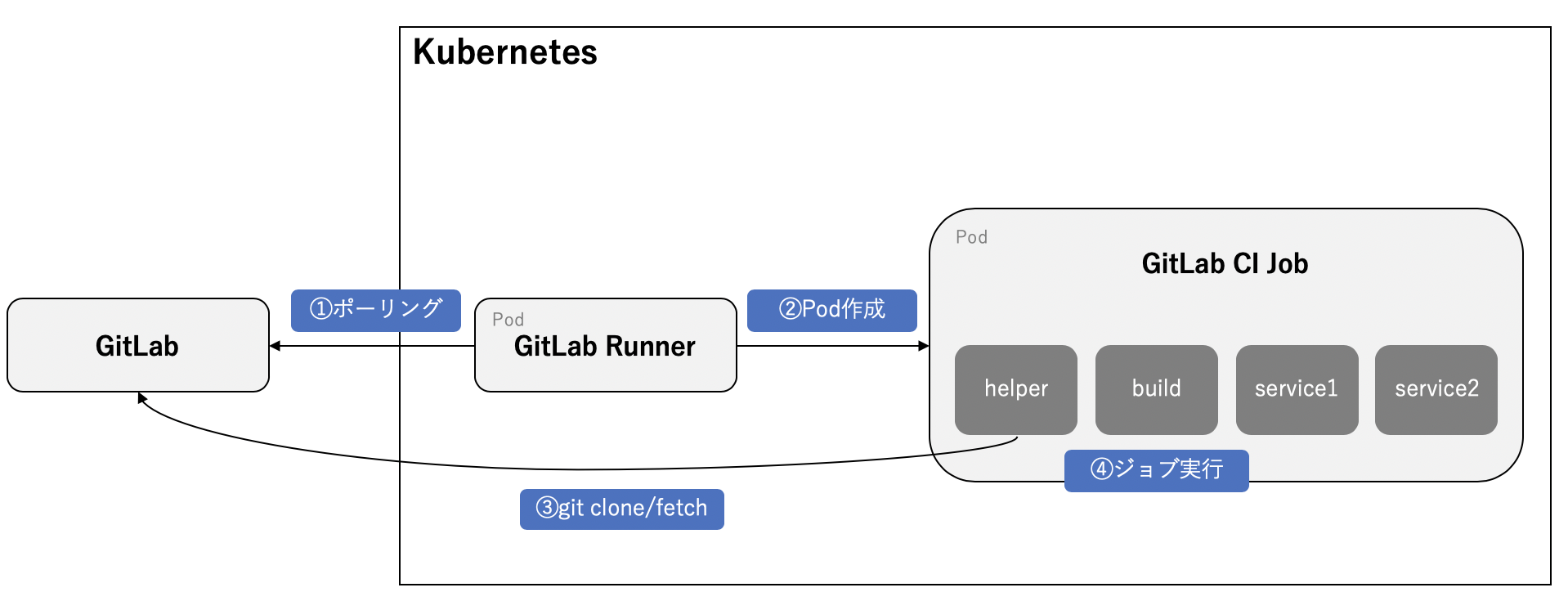

k8s deschedulerを使いこなしてスムーズなオートスケールを実現する

この記事は基本的にGKEでの利用を想定して解説していますが、AWS等他のプロバイダでも大きくは変わりません。適時読み替えてもらえると。

クラスタオートスケーラーの課題点

kubernetesでNodeのオートスケールは、ざっくり説明すると以下のような流れになる訳ですが・・・

- Podの負荷が上がり、HPAによって新しいPodがスケジューリングされる

- PodをスケジューリングさせるためのNodeが不足して、新しいNodeが立ち上がる

- 新しいNodeにPodが立ち上がる

このスケーリングには少々問題がありまして、新しいNodeがすぐに有効活用されるかと言えば、そうでも無いんですよね・・・

時間が経つに連れて新しいNodeにもPodが増えますし、負荷も分散されて行くでしょう。しかし、すでに負荷が上がりきっている既存Nodeに配置されているPodが再スケジューリングされる訳では無いので、急なスパイク等には対応できません。GKEだとNodeの立ち上がり自体は早いんですけどね・・・

deschedulerで負荷が高いNodeのPodを再スケジューリングする

そこでdeschedulerの出番です。deschedulerは条件に応じてPodを削除するためのリソースですね。

https://github.com/kubernetes-sigs/descheduler

上手く利用することで、負荷の高いNodeから負荷の低いNodeにPodを移動させることが可能になります。

導入

基本的にはGithubのREADMEに書いてある通りに進めればOKです

Docker Imageの作成

以下にImageの作成方法が説明してあります。

https://github.com/kubernetes-sigs/descheduler#running-descheduler-as-a-job-inside-of-a-pod

Imageが完成したら、GCPならGCR、AWSだったらECR等に適当にアップロードします。

権限周りの設定

各クラスタに応じて、権限周りの設定を行います。適宜必要な設定を済ませておいて下さい。

https://github.com/kubernetes-sigs/descheduler#create-a-cluster-role

ConfigMapによるDeschedulerPolicyの設定

deschedulerにはいくつかの機能が搭載されていますが、今回利用するのはLowNodeUtilizationという機能です。Nodeの消費済みリソースを閾値としてPodを再スケジューリングさせるものですね。

https://github.com/kubernetes-sigs/descheduler#lownodeutilization

LowNodeUtilizationには、二つの設定項目があります。一つ目は

thresholdsで、再スケジューリング先Nodeの条件を指定するものです。もう一つはtargetThresholdsで、これはPodを削除するNodeの条件を指定します。以下は設定の一例です。apiVersion: "descheduler/v1alpha1" kind: "DeschedulerPolicy" strategies: "LowNodeUtilization": enabled: true params: nodeResourceUtilizationThresholds: thresholds: "cpu" : 20 "memory": 30 "pods": 10 targetThresholds: "cpu" : 60 "memory": 80 "pods": 15ちょっと分かりにくいので細分化して説明します。

thresholdsの詳しい説明

まず、上の例で

thresholdsは"cpu": 20、"memory": 30、"pods": 10となっていますね。

これは日本語で説明すると、「リクエスト済みのリソースがNodeの総リソースに対してCPUが20%以内、メモリが30%以内、尚且つ配置済みのPodが10台以内のNodeを再スケジューリング対象とする」と、なります。ここで注意して欲しいのは、cpuとmemoryは割合であること、podsは台数であること、そして、全ての条件を満たすNodeだけが対象になるということです。targetThresholdsの詳しい説明

次に、

targetThresholdsは"cpu": 60、"memory": 80、"pods": 15となっていますね。これも日本語で説明すると、「リクエスト済みのリソースがNodeの総リソースに対してCPUが60%以上、メモリが80%以上、あるいは配置済みのPodが15台以上のNodeをPod削除対象とする」と、なります。注意点としては、cpu、memory、pods、3つの項目の内、いずれか一つの項目を満たせば対象になるという点です。例えばリクエスト済みのcpu率が60%を超えていれば、memoryが20%とかでも対象になります。ConfigMapとして登録する

DeschedulerPolicyをConfigMapとしてクラスタに登録します。

apiVersion: v1 kind: ConfigMap metadata: name: descheduler-policy-configmap namespace: kube-system data: policy.yaml: | apiVersion: "descheduler/v1alpha1" kind: "DeschedulerPolicy" strategies: "LowNodeUtilization": enabled: true params: nodeResourceUtilizationThresholds: thresholds: "cpu" : 20 "memory": 30 "pods": 10 targetThresholds: "cpu" : 60 "memory": 80 "pods": 15再スケジューリング処理を実行するためのCronJobを定義

公式のGithubにはJobを使った方法が紹介されていますが、実際に運用する場合はCronJobで実行させることになるでしょう。以下CronJob定義の一例です。

apiVersion: batch/v1beta1 kind: CronJob metadata: name: descheduler-job namespace: kube-system spec: schedule: "*/30 * * * *" jobTemplate: spec: template: metadata: name: descheduler-pod annotations: scheduler.alpha.kubernetes.io/critical-pod: "" spec: containers: - name: descheduler image: gcr.io/project/descheduler:v1 # アップロードしたimageを指定 volumeMounts: - mountPath: /policy-dir name: policy-volume command: - "/bin/descheduler" args: - "--policy-config-file" - "/policy-dir/policy.yaml" - "--v" - "3" restartPolicy: "Never" serviceAccountName: descheduler-sa volumes: - name: policy-volume configMap: name: descheduler-policy-configmapたくさんのPodが同時に再スケジューリングされるのを防止する

deschedulerのJobを実行すると、対象となるPodが複数ある場合に多くのPodが同時に再スケジューリングされてしまう可能性があります。そこで、

PodDisruptionBudgetを定義して同時に再スケジューリングされるPodを制限します。以下の例だと、対象のdeploymentに属するPodは同時に2台までしか再スケジューリングされなくなります。apiVersion: policy/v1beta1 kind: PodDisruptionBudget metadata: name: sample-pdb spec: maxUnavailable: 2 selector: matchLabels: app: sample # deployment等のlabelを指定まとめ

クラスタオートスケーラーでの利用を想定したdeschedulerの運用方法や、設定項目の詳細に関して紹介させてもらいました。

設定項目に関しては、ちょっと分かりづらい上に、公式のドキュメントにも詳細な挙動が説明されていないので自前で色々検証しました。個人的な不満点としては、deschedulerの対象とするリソースを選択できない点でしょうか。例えば、特定のdeploymentだけdeschedulerによる再スケジューリングの対象にしたい、kube-systemに属するPodは対象にしたくないといった用途に対応できないですね。一応、

Critical podsやDeamonSetは対象外になるなど、ある程度制限はされているみたいですが、こちら側で柔軟な選別は現状出来なさそうです。https://github.com/kubernetes-sigs/descheduler#pod-evictions

絶賛開発中みたいなので、今後にも期待したいです。

- 投稿日:2019-12-21T23:48:40+09:00

k8s Deschedulerを使いこなしてスムーズなオートスケールを実現する

この記事は基本的にGKEでの利用を想定して解説していますが、AWS等他のプロバイダでも大きくは変わりません。適時読み替えてもらえると。

クラスタオートスケーラーの課題点

kubernetesでNodeのオートスケールは、ざっくり説明すると以下のような流れになる訳ですが・・・

- Podの負荷が上がり、HPAによって新しいPodがスケジューリングされる

- PodをスケジューリングさせるためのNodeが不足して、新しいNodeが立ち上がる

- 新しいNodeにPodが立ち上がる

このスケーリングには少々問題がありまして、新しいNodeがすぐに有効活用されるかと言えば、そうでも無いんですよね・・・

時間が経つに連れて新しいNodeにもPodが増えますし、負荷も分散されて行くでしょう。しかし、すでに負荷が上がりきっている既存Nodeに配置されているPodが再スケジューリングされる訳では無いので、急なスパイク等には対応できません。GKEだとNodeの立ち上がり自体は早いんですけどね・・・

deschedulerで負荷が高いNodeのPodを再スケジューリングする

そこでdeschedulerの出番です。deschedulerは条件に応じてPodを削除するためのリソースですね。

https://github.com/kubernetes-sigs/descheduler

上手く利用することで、負荷の高いNodeから負荷の低いNodeにPodを移動させることが可能になります。

導入

基本的にはGithubのREADMEに書いてある通りに進めればOKです

Docker Imageの作成

以下にImageの作成方法が説明してあります。

https://github.com/kubernetes-sigs/descheduler#running-descheduler-as-a-job-inside-of-a-pod

Imageが完成したら、GCPならGCR、AWSだったらECR等に適当にアップロードします。

権限周りの設定

各クラスタに応じて、権限周りの設定を行います。適宜必要な設定を済ませておいて下さい。

https://github.com/kubernetes-sigs/descheduler#create-a-cluster-role

ConfigMapによるDeschedulerPolicyの設定

deschedulerにはいくつかの機能が搭載されていますが、今回利用するのはLowNodeUtilizationという機能です。Nodeの消費済みリソースを閾値としてPodを再スケジューリングさせるものですね。

https://github.com/kubernetes-sigs/descheduler#lownodeutilization

LowNodeUtilizationには、二つの設定項目があります。一つ目は

thresholdsで、再スケジューリング先Nodeの条件を指定するものです。もう一つはtargetThresholdsで、これはPodを削除するNodeの条件を指定します。以下は設定の一例です。apiVersion: "descheduler/v1alpha1" kind: "DeschedulerPolicy" strategies: "LowNodeUtilization": enabled: true params: nodeResourceUtilizationThresholds: thresholds: "cpu" : 20 "memory": 30 "pods": 10 targetThresholds: "cpu" : 60 "memory": 80 "pods": 15ちょっと分かりにくいので細分化して説明します。

thresholdsの詳しい説明

まず、上の例で

thresholdsは"cpu": 20、"memory": 30、"pods": 10となっていますね。

これは日本語で説明すると、「リクエスト済みのリソースがNodeの総リソースに対してCPUが20%以内、メモリが30%以内、尚且つ配置済みのPodが10台以内のNodeを再スケジューリング対象とする」と、なります。ここで注意して欲しいのは、cpuとmemoryは割合であること、podsは台数であること、そして、全ての条件を満たすNodeだけが対象になるということです。targetThresholdsの詳しい説明

次に、

targetThresholdsは"cpu": 60、"memory": 80、"pods": 15となっていますね。これも日本語で説明すると、「リクエスト済みのリソースがNodeの総リソースに対してCPUが60%以上、メモリが80%以上、あるいは配置済みのPodが15台以上のNodeをPod削除対象とする」と、なります。注意点としては、cpu、memory、pods、3つの項目の内、いずれか一つの項目を満たせば対象になるという点です。例えばリクエスト済みのcpu率が60%を超えていれば、memoryが20%とかでも対象になります。ConfigMapとして登録する

DeschedulerPolicyをConfigMapとしてクラスタに登録します。

apiVersion: v1 kind: ConfigMap metadata: name: descheduler-policy-configmap namespace: kube-system data: policy.yaml: | apiVersion: "descheduler/v1alpha1" kind: "DeschedulerPolicy" strategies: "LowNodeUtilization": enabled: true params: nodeResourceUtilizationThresholds: thresholds: "cpu" : 20 "memory": 30 "pods": 10 targetThresholds: "cpu" : 60 "memory": 80 "pods": 15再スケジューリング処理を実行するためのCronJobを定義

公式のGithubにはJobを使った方法が紹介されていますが、実際に運用する場合はCronJobで実行させることになるでしょう。以下CronJob定義の一例です。

apiVersion: batch/v1beta1 kind: CronJob metadata: name: descheduler-job namespace: kube-system spec: schedule: "*/30 * * * *" jobTemplate: spec: template: metadata: name: descheduler-pod annotations: scheduler.alpha.kubernetes.io/critical-pod: "" spec: containers: - name: descheduler image: gcr.io/project/descheduler:v1 # アップロードしたimageを指定 volumeMounts: - mountPath: /policy-dir name: policy-volume command: - "/bin/descheduler" args: - "--policy-config-file" - "/policy-dir/policy.yaml" - "--v" - "3" restartPolicy: "Never" serviceAccountName: descheduler-sa volumes: - name: policy-volume configMap: name: descheduler-policy-configmapたくさんのPodが同時に再スケジューリングされるのを防止する

deschedulerのJobを実行すると、対象となるPodが複数ある場合に多くのPodが同時に再スケジューリングされてしまう可能性があります。そこで、

PodDisruptionBudgetを定義して同時に再スケジューリングされるPodを制限します。以下の例だと、対象のdeploymentに属するPodは同時に2台までしか再スケジューリングされなくなります。apiVersion: policy/v1beta1 kind: PodDisruptionBudget metadata: name: sample-pdb spec: maxUnavailable: 2 selector: matchLabels: app: sample # deployment等のlabelを指定まとめ

クラスタオートスケーラーでの利用を想定したdeschedulerの運用方法や、設定項目の詳細に関して紹介させてもらいました。

設定項目に関しては、ちょっと分かりづらい上に、公式のドキュメントにも詳細な挙動が説明されていないので自前で色々検証しました。個人的な不満点としては、deschedulerの対象とするリソースを選択できない点でしょうか。例えば、特定のdeploymentだけdeschedulerによる再スケジューリングの対象にしたい、kube-systemに属するPodは対象にしたくないといった用途に対応できないですね。一応、

Critical podsやDeamonSetは対象外になるなど、ある程度制限はされているみたいですが、こちら側で柔軟な選別は現状出来なさそうです。https://github.com/kubernetes-sigs/descheduler#pod-evictions

絶賛開発中みたいなので、今後にも期待したいです。

- 投稿日:2019-12-21T23:24:22+09:00

AWS MediaPackage+SPEKEでHLS-AES 128な動画をパッケージング&配信

どうもこんにちは。

みなさん、「動画配信」やって行っていますか?

僕は最近AWSで動画をいじくりまわすシステムを作ってました。

多分これを読んでいるストリーミング畑のあなたはご存知だと思いますが、AWSにはElemental Serviceという総称で動画をいじれる機能があます。ライブ配信・パッケージング・DRM・ABR・オンプレのエンコーダとの連携などなど。

今回は、Elementalの機能の1つであるAWS SPEKEという便利機能について紹介します。AWS SPEKEとは

公式ドキュメント https://docs.aws.amazon.com/speke/latest/documentation/what-is-speke.html

SPEKE = Secure Packager and Encoder Key Exchange

簡単にまとめると、動画のパッケージャ(AWS Elemental)とDRMエンクリプタ間で、DRMキーなどの情報をセキュアにやりとりできる仕様のことです。

SPEKEが定めるI/OインターフェースにのっとってDRM情報(キーやHLS AESのURL)を返すサーバを実装すると、AWS Elementalと連携して動画をDRMすることができます。Multi DRMに対応していたりと、AWSでDRMするハードルを下げてくれる便利ツールです。もうちょっとわかりやすくまとめると、パッケージングは今まで通りAWS Elementalに任せて

DRMに必要な暗号化キーなどの情報の生成を、こっち側で作ったサーバにオフロードできるようになるということですね(オフロードの本来の意味と少しずれますがイメージ的に)。これによって動画ごとにユニークなキーを生成できたり、キーのプロバイダをクラウド・オンプレ好きな場所に構築することができるようになり、色々ハッピーなことが起こります。

SPEKEを使ってみよう

https://docs.aws.amazon.com/speke/latest/documentation/standard-payload-components.html

SPEKEはDASH IFのCPIX(Content Protection Information eXchange)という仕様をラップしています(という認識ですが、間違ってたら教えてください)。

DASH IF CPIXについての説明はこちら https://docs.unified-streaming.com/documentation/drm/cpix_intro.html

(公式のドキュメントではありませんが、分かりやすかったのでUnified Streaming社のドキュメントを貼ってます)CPIXはDRMに必要な情報をXMLベースでやりとりする仕様らしいです。正直あんまりよく分かってないんですがドキュメントに書いてある通りにデータを送ればだいたい動くので神です。

SPEKEにおいても、基本的にCPIXにのっとってXMLでデータをやりとりします。公式にVOD動画をパッケージングするときのリクエスト・レスポンス例が載っているので今回はこれを参考に

HLS AES 128で暗号化してみたいと思います。

VOD Workflow Method Call Examples - https://docs.aws.amazon.com/speke/latest/documentation/vod-workflow-methods.html1. SPEKE準拠なキーサーバを実装

いきなりですが今回実装したコードを置いちゃいます。

https://github.com/OdaDaisuke/aws-speke下記のリファレンス実装を参考にやって行きました。

awslabs/speke-reference-server - https://github.com/awslabs/speke-reference-server基本的には、リクエストで受け取ったCPIXのXMLを埋めていく処理を書くだけです。

詳しい処理については後述のステップで解説していきます。さて、キーサーバのセットアップですが今回はLambda + API Gatewayで行なっていきます。

上記コードをLambdaにアップしたら、以下のスクショにならって環境変数を設定しましょう。

KEY_STORE_BASE_URLは、HLSのマニフェストファイルのext-x-keyのベースURLになります。事前に空のバケットを作って外部からアクセスできるようにACLなど設定しましょう。

2番目のKEY_STORE_BUCKETはClearKeyを保存するバケットの名前です。そしたら、Lambda用のロールを作成して設定してあげます。この時S3とMediaPackageとAPI Gatewayの操作ポリシーを指定してあげます。

また、同時にAPI Gatewayもセットアップして適当な名前のエンドポイントでキーサーバを叩けるようにしていきますが、今回はリファレンス実装にならってcopy_protectionというエンドポイントを作りました。ちなみにこのキーサーバはAWS内部から叩けられればOKなので外部には公開しなくて大丈夫です。

※説明が駆け足ですいません..

2. Role作成

SPEKEはMedia Live、Media Packageと連携することができますが、今回はMediaPackageと連携してみます。

最初にMediaPackageのRoleを作成します。

現在ロール作成時にデフォルトでMediaPackageを選択することができないので、最初にMediaConvertのロールとして作成した後

以下のように「信頼されたエンティティ」をmediapackage.aws.comに変更、さらにMediaPackageのFullAccessポリシーをアタッチしてください。

3. MediaPackageでパッケージング

まずは下記スクショのPackaging groupsというところから適当な名前でパッケージグループを作成してください。

次にHLS AES128のパッケージング設定を作成します。

General Settingsはこのように、

Enable Encryptionにはチェックを入れ、追加で出てくる入力フォームはこのような設定に。

Constant Initialization Vectorは、先述したIVのことで、適当な値をUUID形式で入れておけばOKです。

Key server URLには先ほど作成したキーサーバのAPI GatewayのURLを、

Role Arnには先ほど作成したMedia PackageのARNを入れ、

最後にSystem IDを設定。このSystem IDですが、HLS AESは正確にはDRMではないためSystem IDは定義されていないので、適当な値をUUID形式で入力しておきます。今回はコード側 https://github.com/OdaDaisuke/aws-speke/blob/master/src/server_response_builder.py#L13 で定義した81376844-f976-481e-a84e-cc25d39b0b33という値を設定してみました。ここまできたらパッケージングの設定は完璧です。

Save Settingを押して次に進みます。Ingest Asset

再びMediaPackageのホーム画面に戻り、

Asset->Ingest Assetに進みます。

パッケージングしたい動画があるバケットを選択し、IAM Roleには先ほど作成したMedia Packageのロールを選択します。ページ中程にある

Asset Detailsは、m3u8ファイルを選択しましょう。この時親子構造のマニフェストでなければパッケージングできないので注意です。詳しくは、https://qiita.com/daisukeoda/items/1eecfd639aeae6f1026c を参照。

最後のPackaging settingsは、先ほど作成したパッケージング設定を選択。

そして最後に「Ingest assets」を押せば、あとは勝手にDRMしつつパッケージングしてくれます。

ボタンを押したあとは下記のようにAssetsの項目が増えているはず。

最後に、項目のタイトルをクリックしてみるとこのようにPlayback details欄に再生URLが表示されているのでテスト再生してみましょう。

HLSなのでSafariで再生テストしたいわけですが、Media Packageのurlをそのまま入力するとクロスオリジンの設定で弾かれてしまうので、Whitelistに

Originを設定したCloud Frontを噛まします。そしたら、この https://videojs.github.io/videojs-contrib-hls/ HLS.jsのテストプレーヤをsafariで開き、urlを入力。

指定のurlに向かってキーがリクエストされ、復号して再生できていれば完璧です。

4. キーサーバの処理について

SPEKEキーサーバのログをみてみると、以下のようなリクエストを受け取っています。

<?xml version="1.0" encoding="UTF-8"?> <cpix:CPIX xmlns:cpix="urn:dashif:org:cpix" xmlns:pskc="urn:ietf:params:xml:ns:keyprov:pskc" xmlns:speke="urn:aws:amazon:com:speke" id="コンテンツID"> <cpix:ContentKeyList> <cpix:ContentKey kid="00112233-4455-6677-8899-aabbccddeeff"></cpix:ContentKey> </cpix:ContentKeyList> <cpix:DRMSystemList> <cpix:DRMSystem kid="00112233-4455-6677-8899-aabbccddeeff" systemId="81376844-f976-481e-a84e-cc25d39b0b33"> <cpix:PSSH /> <cpix:ContentProtectionData /> <cpix:URIExtXKey /> <speke:KeyFormat /> <speke:KeyFormatVersions /> <speke:ProtectionHeader /> </cpix:DRMSystem> </cpix:DRMSystemList> </cpix:CPIX>そしてレスポンスは以下のようなXMLです。

<cpix:CPIX xmlns:cpix="urn:dashif:org:cpix" xmlns:pskc="urn:ietf:params:xml:ns:keyprov:pskc" xmlns:speke="urn:aws:amazon:com:speke" id="コンテンツID"> <cpix:ContentKeyList> <cpix:ContentKey explicitIV="IV(UUID形式)のHEXバイナリをbase64した文字列" kid="00112233-4455-6677-8899-aabbccddeeff"> <cpix:Data> <pskc:Secret> <pskc:PlainValue>暗号化キー(UUID形式)のHEXバイナリをbase64した文字列</pskc:PlainValue> </pskc:Secret> </cpix:Data> </cpix:ContentKey> </cpix:ContentKeyList> <cpix:DRMSystemList> <cpix:DRMSystem kid="00112233-4455-6677-8899-aabbccddeeff" systemId="81376844-f976-481e-a84e-cc25d39b0b33"> <cpix:URIExtXKey>キーurlをbase64エンコードした文字列</cpix:URIExtXKey> <speke:KeyFormat>aWRlbnRpdHk=</speke:KeyFormat> <speke:KeyFormatVersions>MQ==</speke:KeyFormatVersions> </cpix:DRMSystem> </cpix:DRMSystemList> </cpix:CPIX>記事の最初の方に書いた、CPIXのXMLですね。

意味を軽く説明してみますと、

cpix:ContentKeyListのexplicitIVは、AES128またはSAMPLE AESでの暗号化の時に使うもので、CBCブロック暗号化の際に使う初期化ベクトルです。MediaPackageでIVを設定していればリクエスト時にexplicitIV属性に値が入ってくるのかと思ったんですが、どうも何も入っていなかったですね、、、(バグなのか??)。pskc:PlainValueはコンテンツの暗号化キーが入ります。

cpix:DRMSystemListの配下の要素には、DRMに使う情報を格納します。今回の場合(AES)だとURIExtXkey、KeyFormat、KeyFormatVersionsだけ必要なのでそれらの情報を埋めてあげます。

cpix:PSSHとcpix:ContentProtectionDataとspeke:ProtectionHeaderはHLS AESの際には必要ないので、要素ごと削除してレスポンスしている感じです。これらはWidevineやPlayReadyでDRMする際に共通して必要になってきますが、今回は解説しません。以上、SPEKEの最低限の説明でした。今回は説明をわかりやすくするためキーをS3にそのまま保存してましたが、本当はSSEモードで保存したり、Secrets Managerで保存させるなどセキュアに管理した方が良いと思います?♂️。

まとめ

HLS AESにおける処理を紹介してみましたが、SPEKEは他にもWidevineやPlayReady、FairplayなどのメジャーDRMに対応していたり、キーの回転やキー暗号化など、色々なことができます。

まだまだ技術が枯れておらず、そもそものDRMの仕組みを知っていないと実装にかなり苦戦しますが、結構便利な機能だと思いました。

よきDRMライフを。

- 投稿日:2019-12-21T23:24:22+09:00

AWS SPEKEでHLS-AES 128な動画をパッケージング&配信

どうもこんにちは。

みなさん、「動画配信」やって行っていますか?

僕は最近AWSで動画をいじくりまわすシステムを作ってました。

多分これを読んでいるストリーミング畑のあなたはご存知だと思いますが、AWSにはElemental Serviceという総称で動画をいじれる機能があます。ライブ配信・パッケージング・DRM・ABR・オンプレのエンコーダとの連携などなど。

今回は、Elementalの機能の1つであるAWS SPEKEという便利機能について紹介します。AWS SPEKEとは

公式ドキュメント https://docs.aws.amazon.com/speke/latest/documentation/what-is-speke.html

SPEKE = Secure Packager and Encoder Key Exchange

簡単にまとめると、動画のパッケージャ(AWS Elemental)とDRMエンクリプタ間で、DRMキーなどの情報をセキュアにやりとりできる仕様のことです。

SPEKEが定めるI/OインターフェースにのっとってDRM情報(キーやHLS AESのURL)を返すサーバを実装すると、AWS Elementalと連携して動画をDRMすることができます。Multi DRMに対応していたりと、AWSでDRMするハードルを下げてくれる便利ツールです。もうちょっとわかりやすくまとめると、パッケージングは今まで通りAWS Elementalに任せて

DRMに必要な暗号化キーなどの情報の生成を、こっち側で作ったサーバにオフロードできるようになるということですね(オフロードの本来の意味と少しずれますがイメージ的に)。これによって動画ごとにユニークなキーを生成できたり、キーのプロバイダをクラウド・オンプレ好きな場所に構築することができるようになり、色々ハッピーなことが起こります。

SPEKEを使ってみよう

https://docs.aws.amazon.com/speke/latest/documentation/standard-payload-components.html

SPEKEはDASH IFのCPIX(Content Protection Information eXchange)という仕様をラップしています(という認識ですが、間違ってたら教えてください)。

DASH IF CPIXについての説明はこちら https://docs.unified-streaming.com/documentation/drm/cpix_intro.html

(公式のドキュメントではありませんが、分かりやすかったのでUnified Streaming社のドキュメントを貼ってます)CPIXはDRMに必要な情報をXMLベースでやりとりする仕様らしいです。正直あんまりよく分かってないんですがドキュメントに書いてある通りにデータを送ればだいたい動くので神です。

SPEKEにおいても、基本的にCPIXにのっとってXMLでデータをやりとりします。公式にVOD動画をパッケージングするときのリクエスト・レスポンス例が載っているので今回はこれを参考に

HLS AES 128で暗号化してみたいと思います。

VOD Workflow Method Call Examples - https://docs.aws.amazon.com/speke/latest/documentation/vod-workflow-methods.html1. SPEKE準拠なキーサーバを実装

いきなりですが今回実装したコードを置いちゃいます。

https://github.com/OdaDaisuke/aws-speke下記のリファレンス実装を参考にやって行きました。

awslabs/speke-reference-server - https://github.com/awslabs/speke-reference-server基本的には、リクエストで受け取ったCPIXのXMLを埋めていく処理を書くだけです。

詳しい処理については後述のステップで解説していきます。さて、キーサーバのセットアップですが今回はLambda + API Gatewayで行なっていきます。

上記コードをLambdaにアップしたら、以下のスクショにならって環境変数を設定しましょう。

KEY_STORE_BASE_URLは、HLSのマニフェストファイルのext-x-keyのベースURLになります。事前に空のバケットを作って外部からアクセスできるようにACLなど設定しましょう。

2番目のKEY_STORE_BUCKETはClearKeyを保存するバケットの名前です。そしたら、Lambda用のロールを作成して設定してあげます。この時S3とMediaPackageとAPI Gatewayの操作ポリシーを指定してあげます。

また、同時にAPI Gatewayもセットアップして適当な名前のエンドポイントでキーサーバを叩けるようにしていきますが、今回はリファレンス実装にならってcopy_protectionというエンドポイントを作りました。ちなみにこのキーサーバはAWS内部から叩けられればOKなので外部には公開しなくて大丈夫です。

※説明が駆け足ですいません..

2. Role作成

SPEKEはMedia Live、Media Packageと連携することができますが、今回はMediaPackageと連携してみます。

最初にMediaPackageのRoleを作成します。

現在ロール作成時にデフォルトでMediaPackageを選択することができないので、最初にMediaConvertのロールとして作成した後

以下のように「信頼されたエンティティ」をmediapackage.aws.comに変更、さらにMediaPackageのFullAccessポリシーをアタッチしてください。

3. MediaPackageでパッケージング

まずは下記スクショのPackaging groupsというところから適当な名前でパッケージグループを作成してください。

次にHLS AES128のパッケージング設定を作成します。

General Settingsはこのように、

Enable Encryptionにはチェックを入れ、追加で出てくる入力フォームはこのような設定に。

Constant Initialization Vectorは、先述したIVのことで、適当な値をUUID形式で入れておけばOKです。

Key server URLには先ほど作成したキーサーバのAPI GatewayのURLを、

Role Arnには先ほど作成したMedia PackageのARNを入れ、

最後にSystem IDを設定。このSystem IDですが、HLS AESは正確にはDRMではないためSystem IDは定義されていないので、適当な値をUUID形式で入力しておきます。今回はコード側 https://github.com/OdaDaisuke/aws-speke/blob/master/src/server_response_builder.py#L13 で定義した81376844-f976-481e-a84e-cc25d39b0b33という値を設定してみました。ここまできたらパッケージングの設定は完璧です。

Save Settingを押して次に進みます。Ingest Asset

再びMediaPackageのホーム画面に戻り、

Asset->Ingest Assetに進みます。

パッケージングしたい動画があるバケットを選択し、IAM Roleには先ほど作成したMedia Packageのロールを選択します。ページ中程にある

Asset Detailsは、m3u8ファイルを選択しましょう。この時親子構造のマニフェストでなければパッケージングできないので注意です。詳しくは、https://qiita.com/daisukeoda/items/1eecfd639aeae6f1026c を参照。

最後のPackaging settingsは、先ほど作成したパッケージング設定を選択。

そして最後に「Ingest assets」を押せば、あとは勝手にDRMしつつパッケージングしてくれます。

ボタンを押したあとは下記のようにAssetsの項目が増えているはず。

最後に、項目のタイトルをクリックしてみるとこのようにPlayback details欄に再生URLが表示されているのでテスト再生してみましょう。

HLSなのでSafariで再生テストしたいわけですが、Media Packageのurlをそのまま入力するとクロスオリジンの設定で弾かれてしまうので、Whitelistに

Originを設定したCloud Frontを噛まします。そしたら、この https://videojs.github.io/videojs-contrib-hls/ HLS.jsのテストプレーヤをsafariで開き、urlを入力。

指定のurlに向かってキーがリクエストされ、復号して再生できていれば完璧です。

4. キーサーバの処理について

SPEKEキーサーバのログをみてみると、以下のようなリクエストを受け取っています。

<?xml version="1.0" encoding="UTF-8"?> <cpix:CPIX xmlns:cpix="urn:dashif:org:cpix" xmlns:pskc="urn:ietf:params:xml:ns:keyprov:pskc" xmlns:speke="urn:aws:amazon:com:speke" id="コンテンツID"> <cpix:ContentKeyList> <cpix:ContentKey kid="00112233-4455-6677-8899-aabbccddeeff"></cpix:ContentKey> </cpix:ContentKeyList> <cpix:DRMSystemList> <cpix:DRMSystem kid="00112233-4455-6677-8899-aabbccddeeff" systemId="81376844-f976-481e-a84e-cc25d39b0b33"> <cpix:PSSH /> <cpix:ContentProtectionData /> <cpix:URIExtXKey /> <speke:KeyFormat /> <speke:KeyFormatVersions /> <speke:ProtectionHeader /> </cpix:DRMSystem> </cpix:DRMSystemList> </cpix:CPIX>そしてレスポンスは以下のようなXMLです。

<cpix:CPIX xmlns:cpix="urn:dashif:org:cpix" xmlns:pskc="urn:ietf:params:xml:ns:keyprov:pskc" xmlns:speke="urn:aws:amazon:com:speke" id="コンテンツID"> <cpix:ContentKeyList> <cpix:ContentKey explicitIV="IV(UUID形式)のHEXバイナリをbase64した文字列" kid="00112233-4455-6677-8899-aabbccddeeff"> <cpix:Data> <pskc:Secret> <pskc:PlainValue>暗号化キー(UUID形式)のHEXバイナリをbase64した文字列</pskc:PlainValue> </pskc:Secret> </cpix:Data> </cpix:ContentKey> </cpix:ContentKeyList> <cpix:DRMSystemList> <cpix:DRMSystem kid="00112233-4455-6677-8899-aabbccddeeff" systemId="81376844-f976-481e-a84e-cc25d39b0b33"> <cpix:URIExtXKey>キーurlをbase64エンコードした文字列</cpix:URIExtXKey> <speke:KeyFormat>aWRlbnRpdHk=</speke:KeyFormat> <speke:KeyFormatVersions>MQ==</speke:KeyFormatVersions> </cpix:DRMSystem> </cpix:DRMSystemList> </cpix:CPIX>記事の最初の方に書いた、CPIXのXMLですね。

意味を軽く説明してみますと、

cpix:ContentKeyListのexplicitIVは、AES128またはSAMPLE AESでの暗号化の時に使うもので、CBCブロック暗号化の際に使う初期化ベクトルです。MediaPackageでIVを設定していればリクエスト時にexplicitIV属性に値が入ってくるのかと思ったんですが、どうも何も入っていなかったですね、、、(バグなのか??)。pskc:PlainValueはコンテンツの暗号化キーが入ります。

cpix:DRMSystemListの配下の要素には、DRMに使う情報を格納します。今回の場合(AES)だとURIExtXkey、KeyFormat、KeyFormatVersionsだけ必要なのでそれらの情報を埋めてあげます。

cpix:PSSHとcpix:ContentProtectionDataとspeke:ProtectionHeaderはHLS AESの際には必要ないので、要素ごと削除してレスポンスしている感じです。これらはWidevineやPlayReadyでDRMする際に共通して必要になってきますが、今回は解説しません。以上、SPEKEの最低限の説明でした。今回は説明をわかりやすくするためキーをS3にそのまま保存してましたが、本当はSSEモードで保存したり、Secrets Managerで保存させるなどセキュアに管理した方が良いと思います?♂️。

まとめ

HLS AESにおける処理を紹介してみましたが、SPEKEは他にもWidevineやPlayReady、FairplayなどのメジャーDRMに対応していたり、キーの回転やキー暗号化など、色々なことができます。

まだまだ技術が枯れておらず、そもそものDRMの仕組みを知っていないと実装にかなり苦戦しますが、結構便利な機能だと思いました。

よきDRMライフを。

- 投稿日:2019-12-21T22:23:12+09:00

AWSからリリースされた、JavaでDeepLearningが扱えるライブラリDeep Java Library(DJL)に触れてみる

概要

2019/12/03AWSよりJava で機械学習モデルを開発およびデプロイするDeep Java Libraryが発表されました。

ほんの少しですが、触ってみましたので紹介します。

なお、事前知識としては、Javaは普段使っているが、ML/DLの知識は自身ほぼゼロです。ここでは、

Java で深層学習モデルを開発するためのオープンソースライブラリである DJL を発表します。DJL には、深層学習モデルのトレーニング、テスト、デプロイを行うためのユーザーに使いやすい API が用意されています。深層学習に興味のある Java ユーザーであれば、DJL は素晴らしい出発点になります。深層学習モデルで作業する Java 開発者の場合、DJL を使えば簡単に予測をトレーニングして実行することができます。

とありましたので、期待して触ってみます。

なお、公式なページは以下ですが、Amazon/AWS色はあまり見えません。

https://djl.ai/Try

何はともあれ、チュートリアル通り動かしてみます。

https://github.com/awslabs/djl.git

からcloneし、example以下を動かすのが良さそうです。

# 適当なフォルダで実行 git clone https://github.com/awslabs/djl/cloneし終えたら、exampleフォルダに移動し、そこのREADME.mdを見てみます。

以下のように、いろいろな種類の例があるので最初に一つ目の奴をやってみます。

Single-shot Object Detection exampleをやっていきます。

まず初めにセットアップせよと言われますが、Java11+と環境変数、オプションでIntelliJでの使い方ぐらいですので、普段Javaやっている人はあまり読まずに突き進んでも良さそうです。

この例では、予め用意されたZooModelというものを使い、それに対して画像をぶつけてそこに何の動物が映っているのかを表現してくれ、その認識した箇所を四角で囲った画像も作る、という例となります。

いきなりですが、以下で動作確認することが出来ます。

(object_detection.mdより引用)cd examples

./gradlew run -Dmain=ai.djl.examples.inference.ObjectDetection実行結果として、以下が表示されます。

初回はライブラリのダウンロードなどが走るため、時間がかかりますが、2回目以降は10秒程度で終わります。$ ./gradlew run -Dmain=ai.djl.examples.inference.ObjectDetection > Task :run Loading: 100% |████████████████████████████████████████| [22:02:10] src/nnvm/legacy_json_util.cc:209: Loading symbol saved by previous version v1.5.0. Attempting to upgrade... [22:02:10] src/nnvm/legacy_json_util.cc:217: Symbol successfully upgraded! [INFO ] - Detected objects image has been saved in: build/output/detected-dog_bike_car.png [INFO ] - [ class: "car", probability: 0.99991, bounds: [x=0.611, y=0.137, width=0.293, height=0.160] class: "bicycle", probability: 0.95385, bounds: [x=0.162, y=0.207, width=0.594, height=0.588] class: "dog", probability: 0.93752, bounds: [x=0.168, y=0.350, width=0.274, height=0.593] ] BUILD SUCCESSFUL in 11s 3 actionable tasks: 1 executed, 2 up-to-date車と自転車と犬が写っているという結果が出てます。

後付けになりますが、ai.djl.examples.inference.ObjectDetectionクラスを見ると

Path imageFile = Paths.get("src/test/resources/dog_bike_car.jpg");

実行後、出力された画像は

build/output/detected-dog_bike_car.pngにあります。(同クラスに実装されています)ちゃんと出来てますね。

Inputの画像を差し替えることで、別の画像でもObject Detectionできそうです。

改めて

ai.djl.examples.inference.ObjectDetectionクラスを見ると、Javaしかわからない自分にでもなんとなくやっていることがわかります。ロガーの設定などが馴染みがあって親近感湧きますね。全部でおおまかな流れは以下のように読み取りました。

- ロガーの設定

- Inputとなる画像の読み込み

- モデルに渡す各種パラメータの設定

- MxModelZoo(MxNetベースのモデル)という予め用意されたモデルへパラメータ、画像を渡す

- 予測の実施

- 予測結果を画像へ反映

- 標準出力にも予測結果を出力

といった感じです。パラメータのところはそれぞれどんな意味があるのか詳細確認が必要ですが、用意されたモデルを使ってObject Detectionするというのはハードルが低いなと正直思いました。

依存ライブラリの確認

exampleを取り込んだプロジェクトの依存ライブラリは以下のような感じでした。

Spring系との重複とかはなさそうなので、コンフリクト起きずに併用できそうですね。

まとめ

とりあえずDJLを使って、一つの例だけやってみました。

以前、DeepLearning4Jを触ってみようかと思ったのですが、

環境構築周りで躓き、棚上げしていたのですが、今回はすんなりでした。ML/DLのシステムを全てJavaで!という感覚までは辿り着けませんでしたが、一般的なWebシステムの一機能だけML/DLを使うという際には、これをスモールスタートで使ってみるというのは良いかもしれないなと思いました。

- 投稿日:2019-12-21T22:14:37+09:00

AWS RekognitionとRaspberry Piでプリン警備システムを作ってみた

この記事はIoTLT Advent Calendar 2019(Neo)の21日目の記事です。

作ったもの

今回はAmazon Rekognitionを使った職場のプリンを守る警備システムを作りました。

これで大切な職場のプリンを守ります。

aNo研様のSIerIoTLT vol.16発表で職場のプリンを守る技術を知り、警備といえばプリンだなと思い製作しました。

今回はRaspberry Piのプログラムをメインに記事を書きました。

他の部分に興味のある方がいらっしゃいましたらコメント頂けると嬉しいです。使い方

オーナー、過去に人のプリンを食べた人(=犯人)、怪しい人の3種類の人間を識別します。

オーナーが現れた場合は動作していることをTwitterで報告します。

犯人が現れた場合はゴム鉄砲を発射し警告音を鳴らします。同時にゴム鉄砲発射直後のカメラ画像を送りオーナーはTwitterで確認できます。

オーナー、犯人以外の人が現れた場合は怪しい人と認識。警告音で威嚇し犯人同様カメラ画像をTwitterでカメラ画像を確認できます。

※予めオーナーと犯人の顔写真はAmazon Rekognitionに登録します。構成

Raspberry Pi(ハードウェア)

おおよその構成はこんな感じです。

色々雑ですが、レゴを使ってカメラモジュールとゴム鉄砲を固定しています。

Raspberry Pi(ソフトウェア)

おおよその流れは以下の通りです。

- Amazon Rekognitionに予め所有者と犯人の2種類の顔を登録します。

- CameraModuleで画像を取得しまずOpenCVでカメラ内に人の顔があるか検知します。

- 顔があればboto3経由でAmazon Rekognitionにカメラ映像を送り問い合わせを行います。

- Amazon Rekognitionはカメラ映像にある顔が登録された所有者と犯人である確率を返します。それを元に所有者/犯人/(どちらでもない)怪しい人を判断します。

- 所有者であればIFTTT経由で動作状況をTwitterで報告します。

- 犯人であれば以下の動作をします。

- Pigpio経由でServoを動かしゴム鉄砲を発射!

- ゴム鉄砲発車後の画像を取得。

- 警告音を出します。

- S3にboto3経由でカメラ画像をアップしてIFTTT経由で所有者にTwitterで報告します。

- 怪しい人であれば以下の動作をします。

- 警告音を出します。

- S3にboto3経由でカメラ画像をアップしてIFTTT経由で所有者にTwitterで報告します。

Raspberry Piのプログラムはこちら。

demo.py# -*- coding: utf-8 -*- from picamera.array import PiRGBArray from picamera import PiCamera import cv2, time, boto3 import requests import urllib.request, json import datetime import numpy as np from PIL import ImageFont, ImageDraw, Image import subprocess from datetime import datetime as dt import pigpio # Pi Camera FRAME_W = 640 FRAME_H = 480 # Open CV CASC_PATH = '/usr/local/share/opencv4/lbpcascades/lbpcascade_frontalface.xml' FRAME_RATE = 32 MIN_FACE_SIZE = 10 CHECK_FILE = 'check.jpg' # AWS Rekognition COLLECTION_ID = 'test' THRESHOLD = 70 MAX_FACES = 1 SERVICE_NAME = 'rekognition' LOCATE = 'ap-northeast-1' PERSON_TYPE = {0:'怪しい人', 1:'Owner', 2:'犯人', 3:''} # S3 S3_URL = 'https://s3-ap-northeast-1.amazonaws.com/' BUCKET_NAME = 'test' # IFTTT (Webhooks Settings) TRIGGER = 'rekognition' URL1 = 'https://maker.ifttt.com/trigger/' URL2 = '/with/key/xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx' EVENT = {0:'other', 1:'owner', 2:'enemy', 3:''} MESSAGE = {0:'怪しい奴がきたよ', 1:'ちゃんと監視してるよ!', 2:'犯人やっつけた!', 3:''} # Servo GPIO_NO = 18 GPIO_READY = 500 GPIO_FIRE = 1600 def rotate_servo(servo, angle): # サーボ操作 if -90 <= angle <= 90: d = ((angle + 90) * 9.5 / 180) + 2.5 servo.ChangeDutyCycle(d) else: raise ValueError("angle") def send_message(msg_no, file_name): # S3にファイルをアップロード dt_now = dt.now() s3_filename = 'img_' + dt_now.strftime('%m%d_%H%M%S') + '.jpg' s3 = boto3.resource('s3') s3.Bucket(BUCKET_NAME).upload_file(file_name, s3_filename, ExtraArgs={"ContentType": "image/jpeg"}) s3_url = S3_URL + BUCKET_NAME + "/" + s3_filename # IFTTT URL設定 url = URL1 + TRIGGER + URL2 method = "POST" headers = {"Content-Type" : "application/json"} date = datetime.datetime.now() message = MESSAGE[msg_no] + ' ' + str(date.hour) + '-' + str(date.minute) print('Send Message:', message) # PythonオブジェクトをJSONに変換する obj = {"value1" : message, "value2" : s3_url} json_data = json.dumps(obj).encode("utf-8") # httpリクエストを準備してPOST request = urllib.request.Request(url, data=json_data, method=method, headers=headers) with urllib.request.urlopen(request) as response: response_body = response.read().decode("utf-8") print('response:',response_body) def aws_rekognition(cl): #顔認証 img = open(CHECK_FILE, 'rb') img_byte = img.read() try: response = cl.search_faces_by_image(CollectionId=COLLECTION_ID, Image={'Bytes':img_byte}, FaceMatchThreshold=THRESHOLD, MaxFaces=MAX_FACES) except: return 3 print('Rekognition!') person="" #カメラに複数人写っていた場合最後の人を判定(手抜き) for faceRecord in response['FaceMatches']: person = faceRecord['Face']['ExternalImageId'] if person.endswith("owner"): rtn = 1 elif person.endswith("bad"): rtn = 2 else: rtn = 0 return rtn #GUI処理 def face_maker(frame, faces, rtn): # フォントを読み込み font = ImageFont.truetype('TanukiMagic.ttf', 48) for (x, y, w, h) in faces: # 見つかった顔を矩形で囲む cv2.rectangle(frame, (x, y), (x+w, y+h), (0, 255, 0), 2) img_pil = Image.fromarray(frame) draw = ImageDraw.Draw(img_pil) draw.text((30, 60), PERSON_TYPE[rtn], font = font, fill = (128,255,0)) frame = np.array(img_pil) return frame def main(): # 初期化 faceCascade = cv2.CascadeClassifier(CASC_PATH) camera = PiCamera() camera.resolution = (FRAME_W, FRAME_H) camera.framerate = FRAME_RATE camera.rotation = 180 rawCapture = PiRGBArray(camera, size=(FRAME_W, FRAME_H)) time.sleep(0.1) client = boto3.client(SERVICE_NAME,LOCATE) pi = pigpio.pi() old_rtn = 3 # ループ for image in camera.capture_continuous(rawCapture, format="bgr", use_video_port=True): frame = image.array #frame = cv2.flip(frame, -1) #上下反転 camera.start_preview() # OpenCVの顔検出をグレースケールで実施 gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY) gray = cv2.equalizeHist( gray ) faces = faceCascade.detectMultiScale(gray, 1.1, 3, 0, (MIN_FACE_SIZE, MIN_FACE_SIZE)) # 表示調整用 #frame = cv2.resize(frame, (800,600)) # 顔あり if faces is not None: # 顔ファイル出力 cv2.imwrite(CHECK_FILE, frame) time.sleep(0.01) # AWS Rekognition rtn = aws_rekognition(client) if rtn is None: rtn = 3 frame = face_maker(frame,faces,rtn) # ビデオに表示 cv2.imshow('Video', frame) time.sleep(0.1) # 同じ結果の場合は何もしない print('rtn:', rtn, ' old_rtn:', old_rtn) if old_rtn != rtn: if(rtn == 0): # 怪しい人 subprocess.call("mpg321 warning.mp3", shell=True) send_message(rtn, CHECK_FILE) if(rtn == 1): # オーナー send_message(rtn, CHECK_FILE) if(rtn == 2): # 過去に人のプリンを食べたことがある人 pi.set_servo_pulsewidth(GPIO_NO, GPIO_READY) time.sleep(0.2) pi.set_servo_pulsewidth(GPIO_NO, GPIO_FIRE) subprocess.call("mpg321 fire.mp3", shell=True) # 攻撃後の画像をTwitterに送る camera.capture('fire.jpg') send_message(rtn, 'fire.jpg') old_rtn = rtn # qを押されたら終了 key = cv2.waitKey(1) & 0xFF rawCapture.truncate(0) if key == ord("q"): break time.sleep(0.01) cv2.destroyAllWindows() exit if __name__ == "__main__": main()IFTTT

Amazon Rekognition

アマゾンウェブサービス(AWS)のAmazon Rekognition は、深層学習に基づいた画像認識および画像分析をアプリケーションに簡単に追加できるサービスです。

予めオーナー(名前の末尾がowner)と犯人(名前の末尾がbad)の画像をAmazon Rekognitionしています。

上記プログラムでboto3を利用してAWSにアクセスするとカメラ映像に近い画像名を返します。

- 投稿日:2019-12-21T22:00:19+09:00

SAM+CodeDeployでlambdaへデプロイする。

前回まではCodeDeployを用いてEC2インスタンスへのデプロイを学習しました。

今回はデプロイ対象をlambdaでやってみたいと思います。CodeDeployのアプリケーション作成画面でlambdaを選択できるので同じ要領かと思っていましたが、SAMというやつを一緒に使うみたいです。公式チュートリアルは普通に分かりやすいです。なので、今回はテンプレートyamlファイルの設定項目をここで指定していきましょう。

contents

- AWS SAM

- AWS CloudFormation

- 公式チュートリアル実施時の備忘録/トラブルシューティング

- template.ymlの解読(本題)

AWS SAM

AWS Serverless Application Model(AWS SAM)は、yaml形式で記述したテンプレートを元にして種々のAWSリソースを用いたアプリケーションを構築することができます。

ローカル上から利用するために、aws-sam-cliを利用します。AWS CloudFront

- テンプレート : アプリケーション全体の設計図(yamlベースもしくはjsonベース:コメントが書けるのでyaml推奨)

- スタック : テンプレートを元にCloudFormationが構築したリソースの集合全体(=環境自体)

CloudFormationで生成する環境は、スタック単位で管理されスタックの破棄とともに紐づいたリソースを全て削除することができる。

公式チュートリアルやってみた

SAM CLIのインストールorアップグレード

公式には以下のようにありますが多分

pipでいけると思います。

https://docs.aws.amazon.com/serverless-application-model/latest/developerguide/serverless-sam-cli-install.htmlアップグレード$ pip install --upgrade awscli $ pip install --upgrade aws-sam-cli $ sam --version

awscliを先に最新版にしたほうがいいです。botocoreのバージョンが一致しないと以下のようにエラーします。エラーメッセージERROR: awscli 1.16.304 has requirement botocore==1.13.40, but you'll have botocore 1.13.44 which is incompatible. Installing collected packages: botocore, boto3, aws-sam-translator, tomlkit, aws-sam-cli Found existing installation: botocore 1.13.40 Uninstalling botocore-1.13.40: ERROR: Could not install packages due to an EnvironmentError: [Errno 13] Permission denied: 'RECORD' Consider using the `--user` option or check the permissions.デプロイの仕組み

最終的にはディレクトリごとzipにするので、デプロイ用のディレクトリを作り、以下の構成にします。

$ tree SAM-Tutorial ├── afterAllowTraffic.js ├── beforeAllowTraffic.js ├── myFunction.js └── template.yml

ファイル 説明 myFunction.js デプロイ対象のファイル template.yml デプロイの流れを書いた仕様書(これが要) beforeAllowTraffic.js AllowTraffic前に実行するテスト afterAllowTraffic.js AllowTraffic後に実行するテスト template.ymlを元にパッケージを作成します。実行すると、

SAM-Tutorialディレクトリ内にpackage.ymlが生成し、S3バケットにはc2fe022d92156eeb459d45f02a766921`が上がっています。$ sam package --template-file template.yml --output-template-file package.yml --s3-bucket YOUR_BUCKET Uploading to c2fe022d92156eeb459d45f02a766921 4113 / 4113.0 (100.00%) Successfully packaged artifacts and wrote output template to file package.yml.続いてデプロイです。

--capabilities CAPABILITY_IAMはCloudFrontからロールを作成するのに必要な権限付与みたいな感じ必要です。sam deploy --template-file package.yml --stack-name my-date-time-app2 --capabilities CAPABILITY_IAM Deploying with following values =============================== Stack name : my-date-time-app2 Region : None Confirm changeset : False Deployment s3 bucket : None Capabilities : ["CAPABILITY_IAM"] Parameter overrides : {} #以下略当たり前なのですが、cliを実行しているIAMユーザに適切に権限を与えていないと途中でエラーします。SAMは、実質CloudFormationを利用しているので、IAMユーザには

CloudFormationFullAccessを適応してください。(FullAccessでなくてもいいのかもしれないが面倒なので未調査)

なお、今回の検証用のユーザは以下のロール適用しました。

(多分不要なものも含んでます。CodeCommiteとか今回使ってないし)

- AWSCodeCommitFullAccess

- AWSLambdaFullAccess

- IAMFullAccess

- AmazonS3FullAccess

- AWSCodeDeployFullAccess

- AWSCloudFormationFullAccess

また、実行途中で失敗した場合、自動的にロールバックされ、ステータスが

ROLLBACK_COMPLETEになります。この状態はから再度sam deployはできません。一度CloudFormationコンソールから削除します(cliでもできるはず)。

ステータスの見方についての公式ページ→https://docs.aws.amazon.com/ja_jp/AWSCloudFormation/latest/UserGuide/cfn-console-view-stack-data-resources.htmlエラーメッセージ..../a417d920-239f-11ea-9fca-0ef015a9ecfc is in ROLLBACK_COMPLETE state and can not be updated.デプロイ中はCodeDeployコンソールで進行状況が把握できる。

デプロイに成功したら、デプロイされたlambdaをコンソールから確認してみましょう。

パッケージ名+関数名+英数字となっているのでarnを取得してcliからinvokeしてみる。$ aws lambda invoke --function arn:aws:lambda:ap-northeast-1:xxxxxxxxxxxx:function:my-date-time-app2-myDateTimeFunction-1S9F2G73JFP32 --payload "{\"option\": \"date\", \"period\": \"today\"}" out.txt { "StatusCode": 200, "ExecutedVersion": "$LATEST" } $ SAM-Tutorial ls afterAllowTraffic.js myDateTimeFunction.js package.yml beforeAllowTraffic.js out.txt template.yml $ SAM-Tutorial cat out.txt {"statusCode":200,"headers":{"Content-type":"application/json"},"body":"{\"month\":12,\"day\":21,\"year\":2019}"}%この後、ローカルでmyDateTimeFunction.jsファイルを更新した場合、上記と同じ手順で

aws packageし、aws deployする。なお、CodeDeployを通してデプロイしたlambdaでもコンソール上で直接変更はできる。ただこの方法で更新したものはversionとして変更履歴に保存されないので注意。

ここからが本題

template.ymlの解読

template.ymlのオプション指定を解読していきます。

Transform(必須)

使用するSAMのバージョンを指定し、使用できるSAM構文とCloudFormationがそれをどのように処理するかを定義します。

AWS::Serverless-2016-10-31を指定する。Globals

グローバル領域。複数のリソースに対して共通の定義をできる。例えば全ての関数でランタイムは

python3.8でメモリは256を指定したいといった場合、Globalsに書くことで以降のAWS::Serverless::Functionの各Functionの項目に書かなくても継承してくれる。

Grobalsで一括定義できるのは以下のみ。

- AWS::Serverless::Function

- AWS::Serverless::Api

- AWS::Serverless::SimpleTable

Grobalsをデフォルト値のようにしてAWS::Serverless::Function側にも定義した場合その関数だけは指定した値に上書きできるとかあるのだろうか?なお、それぞれ何を指定できるかは公式参照→https://docs.aws.amazon.com/ja_jp/serverless-application-model/latest/developerguide/sam-specification-template-anatomy-globals.html

Description

その名の通り説明。

Metadata

メタデータ。追加情報です。まだ使い道がわからない。。。

Parameters

テンプレートを実行するときに、ユーザーに入力させるパラメータを定義できます。

Mappings

連想配列/辞書を定義できます。

Conditions

条件を設定します。真の場合にのみリソースを生成するなどの条件分岐が可能です。

パラメータと組み合わせた例が以下。例Parameters: EnvType: Description: Environment type. Default: test Type: String AllowedValues: - prod - test Conditions: CreateProdResources: !Equals [ !Ref EnvType, prod ] Resources: # CreateProdResourcesがfalseの場合にはインスタンスは作られない。 EC2Instance: Type: "AWS::EC2::Instance" Condition: CreateProdResources Properties: ImageId: !FindInMap [RegionMap, !Ref "AWS::Region", AMI]Output

スタック構築後に、指定した情報を出力する。

Resources(必須)

準備するリソースを指定する。いくつかピックアップして調べてみる。

AutoPublishAlias

チュートリアルのtemplate.yml# Instructs your myDateTimeFunction is published to an alias named "live". AutoPublishAlias: liveこの

AutoPublishAliasはデプロイ対象の関数が変更されたときに検出し、テンプレート上で命名したエイリアスを使用してデプロイするようにフレームワークに指示します。この指定は必須です。

やってみるとわかるのですが、sam deployするとlambdaはバージョン管理されます。$LATESTとは別にエイリアスをつけられます。エイリアスとは、lambdaのバージョン番号に別名を付したものです。

DeploymentPreference Type

チュートリアルのtemplate.ymlDeploymentPreference: # Specifies the deployment configuration Type: Linear10PercentEvery1Minuteここでは新しいバージョンのlambdaへトラフィックを流す割合を定義しています。

Linear10PercentEvery1Minuteは1minのトラッフィクのうち10%を次バージョンへ回す設定です。クラスメソッドの実際の実験がわかりやすいです。

https://dev.classmethod.jp/server-side/serverless/understanding-lambda-deploy-with-codedeploy-using-aws-sam/また、このデプロイのタイプの設定はカナリアリリースなども選択可能であり同じく上記リンクに紹介があります。

DeploymentPreference Hooks

チュートリアルのtemplate.yml# Specifies Lambda functions for deployment lifecycle hooks Hooks: PreTraffic: !Ref beforeAllowTraffic PostTraffic: !Ref afterAllowTraffic

HooksはCodeDeployでEC2へのデプロイ時の設定にもあった通り、各イベントの前後の適切なタイミングで指定したプログラムを実行するための設定です。lmabdaへのデプロイではtrafic allowの前後2つのタイミングを選択できます。公式には以下のように説明があります。(beforeAllowTrafficとafterAllowTrafficはCloudFrontでの指定方法であり、SAMではそれぞれPreTrafficとPostTrafficに対応しております。わかりにくい!)AWS Lambda フックは、ライフサイクルイベントの名前の後の新しい行に文字列で指定された 1 つの Lambda 関数です。各フックはデプロイごとに 1 回実行されます。以下は、AppSpec ファイルに使用できるフックの説明です。

BeforeAllowTraffic – これを使用して、トラフィックがデプロイされた Lambda 関数のバージョンに移行する前にタスクを実行します。

AfterAllowTraffic – これを使用して、トラフィックがデプロイされた Lambda 関数のバージョンに移行した後でタスクを実行します。

用途としては

PreTrafficの段階で単体テストし、成功すればデプロイ、PostTrafficで結合テストし、失敗すればロールバックさせるなど一連の流れを構築できそうです。また、この

Ref!という記法はCloudFrontの組み込み関数で、以下のように読み換えられます。# パラメータ参照 !Ref {パラメーター名} # リソースの返り値を取得 !Ref {リソース名}同じく、

!Subという表現も次に出てきます。

これは文字列とパラメータを組み合わせた値を作成する際に使用します。参考) https://qiita.com/ryurock/items/766154e0afb8fdb629e2

関数ポリシー

チュートリアルのtemplate.yml# Grants this function permission to call codedeploy:PutLifecycleEventHookExecutionStatus Statement: - Effect: "Allow" Action: - "codedeploy:PutLifecycleEventHookExecutionStatus" Resource: !Sub 'arn:aws:codedeploy:${AWS::Region}:${AWS::AccountId}:deploymentgroup:${ServerlessDeploymentApplication}/*' - Version: "2012-10-17"デプロイ前後のテスト用関数から対象の関数をinvokeするにはアクセス許可をする必要があります。(正直lambdaFullアクセスを与えてしまってもいいと思ってます。)

lambda環境変数の指定

チュートリアルのtemplate.ymlEnvironment: Variables: NewVersion: !Ref myDateTimeFunction.Version

- 投稿日:2019-12-21T19:37:30+09:00

code-server オンライン環境篇 (3) Boto3 で EC2 インスタンスを立ち上げる

これは、2019年 code-server に Advent Calender の 第14日目の記事です。

前回に続き、EC2 Instance を 立ち上げたいと思います。

目次

ローカル環境篇 1日目

オンライン環境篇 1日目 作業環境を整備する

オンライン環境篇 2日目 仮想ネットワークを作成する

オンライン環境篇 3日目 Boto3 で EC2 インスタンスを立ち上げる

オンライン環境篇 4日目 Code-Serverをクラウドで動かしてみる

オンライン篇 5日目 Docker環境を構築してアレコレ

オンライン篇 6日目 簡単な起動アプリを作成してみよう

...

オンライン篇 .. Coomposeファイルで構築

オンライン篇 .. K8Sを試してみる

...

魔改造篇はじめに

RouteTable の設定をしていませんでした。 時環境では動いているのですが、

もしかすると動かないかも...で、Route Table の設定から始めます

Route Table とは

前回 Gateway を設定しましたね!! で、VPCからアクセスするIPごとに、どのGatewayを使用するかを設定することができます。

今回の場合だと、全部、Internet Gateway につなげれば良いのですが、

VPC間やSubnet間など、こまめに設定することができます。ネットワークの作成 その2です

Route Table を作成する

作成def create_route_table(vpc_id:str): res = ec2client.create_route_table(VpcId=vpc_id) print("{}".format(res)) route_table_id = res['RouteTable']['RouteTableId'] attach_tag(route_table_id) return route_table_idRoute Table には VPC をしてします。当然ですね..

とかで行けます

Routeを作成する

RouteTable に、全てのIPをInternetに接続可能なように指定しましょう

Routeを作成するdef create_route(route_table_id:str, gateway_id:str): resp = ec2client.create_route(RouteTableId=route_table_id,DestinationCidrBlock="0.0.0.0/0",GatewayId=gateway_id) print("{}".format(resp))

0.0.0.0/0が全てのIPを意味しています。

0.0.0.0から255.255.255.255Subnet に関連付けする

def associate_route_table(route_table_id:str, subnet_id:str): res = ec2client.associate_route_table(RouteTableId=route_table_id,SubnetId=subnet_id) print("{}".format(res)) associate_id = res['AssociationId'] return associate_idRoute Table を削除

def delete_route_table(): print(">>> Delete Route Table") res = ec2client.describe_route_tables(Filters=[{"Name":"tag:Name","Values":[instance_name]}]) print("{}".format(res)) for route_table in res["RouteTables"]: for association in route_table.get('Associations',[]): ec2client.disassociate_route_table(AssociationId = association['RouteTableAssociationId']) res = ec2client.delete_route_table(RouteTableId=route_table['RouteTableId']) print("{}".format(res))削除はこんな感じです。

削除する前に、associate_route_table()を呼び出して、関連付けを外す必要があります。※ 今回、Tagを利用しているのは、説明しやすいからで、

vpc_id などからも、引っ張ってこれるので、vpc_idを使うのが良いかもFilters=[{"Name":"vpc-id","Values":[vpc_id]}]SecurityGroupの修正

前回のコードは、VPCを設定し忘れていました..

作成def create_security_group(vpc_id): print(">>> CREATE SECURITY GROUP") res = ec2client.create_security_group(Description="AdventCodeServer",GroupName=instance_name,VpcId=vpc_id) print("{}".format(res)) group_id = res['GroupId'] attach_tag(group_id) return group_idここまで書いたコードは以下の通り

https://github.com/kyorohiro/advent-2019-code-server/blob/master/remote_cs01/for_aws/main.py

Instance を作成する

PEMファイルを作成する

Instance には、SSH キー を利用して接続をする想定でいます。

秘密鍵と公開鍵を作成しておきましょうPEM作成def create_pem(): pem_file = open("{}.pem".format(instance_name),"w") pem_file.write("") try: print(">>> CREATE KEY_PAIR") res = ec2client.create_key_pair(KeyName=instance_name) print("{}".format(res)) pem_file.write(res['KeyMaterial']) finally: pem_file.close() return instance_namePEM削除def delete_pem(): print(">>>> DELETE KeyPair") ec2client.delete_key_pair(KeyName=instance_name)Instanceを立ち上げる

作成def create_instance(subnet_id:str, group_id:str): print(">>>> CREATE INSTANCE") res = ec2client.run_instances(ImageId="ami-0cd744adeca97abb1",#KeyName="xx", InstanceType='t2.micro', MinCount=1,MaxCount=1,KeyName=instance_name, TagSpecifications=[ { 'ResourceType': 'instance', 'Tags': [{ 'Key': 'Name', 'Value': instance_name }] } ],NetworkInterfaces=[{"SubnetId":subnet_id,'AssociatePublicIpAddress': True,'DeviceIndex':0,'Groups': [group_id]}] ) print("{}".format(res))作成した subnetと group_id を指定します。

今回はUbuntuを指定しました。

https://aws.amazon.com/jp/amazon-linux-ami/削除def delete_instance(): print(">>>> ec2client.describe_instances") res = ec2client.describe_instances( Filters=[{"Name":"tag:Name","Values":[instance_name]}] ) print("{}".format(res)) print(">>>> DELETE Instance") for reservation in res['Reservations']: for instance in reservation['Instances']: instance_id = instance['InstanceId'] res = ec2client.terminate_instances(InstanceIds=[instance_id]) print("{}".format(res))削除も、今前通りですね。

では、今までに作成したものをつなげてみましょう。

スクリプトを走らせる、その前に

Instance の削除が完了するまで待機するスクリプトも書いておきましょう。

def wait_instance_is_terminated(): while(True): res = ec2client.describe_instances( Filters=[{"Name":"tag:Name","Values":[instance_name]}] ) terminated = False for reservation in res['Reservations']: for instance in reservation['Instances']: instance_state = instance['State']['Name'] print("------{}".format(instance_state)) if instance_state != 'terminated': terminated = True if terminated == False: break time.sleep(6)まとめ

main.pyimport boto3 from boto3_type_annotations import ec2 from botocore.exceptions import ClientError from typing import Dict, List import time import network instance_name= "advent-code-server" ec2client:ec2.Client = boto3.client("ec2") def create_pem(): pem_file = open("{}.pem".format(instance_name),"w") pem_file.write("") try: print(">>> CREATE KEY_PAIR") res = ec2client.create_key_pair(KeyName=instance_name) print("{}".format(res)) pem_file.write(res['KeyMaterial']) finally: pem_file.close() return instance_name def delete_pem(): print(">>>> DELETE KeyPair") ec2client.delete_key_pair(KeyName=instance_name) def create_instance(subnet_id:str, group_id:str): print(">>>> CREATE INSTANCE") # Ubuntu Server 18.04 LTS (HVM), SSD Volume Type - ami-0cd744adeca97abb1 (64-bit x86) / ami-0f0dcd3794e1da1e1 (64-bit Arm) # https://aws.amazon.com/jp/amazon-linux-ami/ res = ec2client.run_instances(ImageId="ami-0cd744adeca97abb1",#KeyName="xx", InstanceType='t2.micro', MinCount=1,MaxCount=1,KeyName=instance_name, TagSpecifications=[ { 'ResourceType': 'instance', 'Tags': [ { 'Key': 'Name', 'Value': instance_name } ] } ],NetworkInterfaces=[{"SubnetId":subnet_id,'AssociatePublicIpAddress': True,'DeviceIndex':0,'Groups': [group_id]}] ) print("{}".format(res)) return instance_name def delete_instance(): print(">>>> ec2client.describe_instances") res = ec2client.describe_instances( Filters=[{"Name":"tag:Name","Values":[instance_name]}] ) print("{}".format(res)) print(">>>> DELETE Instance") for reservation in res['Reservations']: for instance in reservation['Instances']: print("------{}".format(instance)) instance_id = instance['InstanceId'] print(">>>> {}".format(instance_id)) res = ec2client.terminate_instances(InstanceIds=[instance_id]) print("{}".format(res)) def wait_instance_is_terminated(): while(True): res = ec2client.describe_instances( Filters=[{"Name":"tag:Name","Values":[instance_name]}] ) terminated = False for reservation in res['Reservations']: for instance in reservation['Instances']: instance_state = instance['State']['Name'] print("------{}".format(instance_state)) if instance_state != 'terminated': terminated = True if terminated == False: break time.sleep(6) if __name__ == "__main__": res = network.create() create_pem() create_instance(res["subnet_id"], res["group_id"]) delete_instance() wait_instance_is_terminated() delete_pem() network.delete()コード全体は、以下

https://github.com/kyorohiro/advent-2019-code-server/tree/master/remote_cs02/for_aws

次回

作成した仮想 Instance を操作してみましょう!!

コード

https://github.com/kyorohiro/advent-2019-code-server/tree/master/remote_cs02

- 投稿日:2019-12-21T19:34:28+09:00

CloudFormationのYAMLを分割管理する

CloudFormation は JSON or YAML で作成したテンプレートを元に構成を管理しています。

コメントが書ける YAML を選択している方も多いかとは思いますが、CloudFormation のテンプレートは1ファイルになっている必要があり、設定項目が多くなると管理がかなり面倒です。JSON も YAML もそれ自体には import や require する機能はないのですが、json-refs(仕様は JSON Reference, JSON Pointer 参照)を使うと別ファイルを参照できるので、簡単にツール化してみました。

使い方

インストール

通常は、CloudFormation を使うプロジェクト内にインストールすれば OK です。

npm install -D @u-minor/cftemplateglobal に入れても OK です。

CloudFormation 分割テンプレートの作成

json-refs は

$ref: another_file.ymlのように、$refを使って別ファイルを指定します。

src/index.ymlを作成し、以下のように CloudFormation のトップレベルの要素を定義、Parameters等の要素を別ファイルに分離します。index.ymlAWSTemplateFormatVersion: '2010-09-09' Description: Test template Parameters: $ref: parameters.yml Resources: $ref: .resources.yml

src/parameters.ymlを作成し、テスト用のパラメータ定義をしてみます。parameters.ymlTestParam: Description: Test parameter Type: String

.resources.ymlのように「.」から始まるファイル名を指定した場合は、直接ファイルを作成せず、「.」を除いたフォルダを作成し、その中に複数の YAML ファイルを入れておくことで、自動的にマージしてくれます。

src/resources/Logs.ymlを作成し、以下のように CloudWatch の LogGroup を指定してみます。Logs.ymlLogGroup: Type: AWS::Logs::LogGroup Properties: LogGroupName: !Sub ${AWS::StackName}/${TestParam}/json-refs はノードに対して1ファイルを import する仕様なので、CloudFormation の Resources(1ノード)の中を複数ファイル分割しようとすると、json-refs のみでは対応できません。

ですので、この部分は独自にマージする仕様となっています。CloudFormation テンプレートのビルド

cftemplateコマンドで src フォルダを指定すると、ビルドされたテンプレートが標準出力にアウトプットされるので、以下のようにリダイレクトでファイルに向けます。npx cftemplate src > stack.yml以下のようなテンプレートが出力されれば成功です。

stack.ymlAWSTemplateFormatVersion: '2010-09-09' Description: Test template Parameters: TestParam: Description: Test parameter Type: String Resources: LogGroup: Type: 'AWS::Logs::LogGroup' Properties: LogGroupName: !Sub '${AWS::StackName}/${TestParam}/'AWS CDK が使える今、CloudFormation テンプレートを直接管理する必要性は以前ほど少なくなってきてはいると思いますが、YAML でシンプルに定義できるメリットはまだまだあると感じています。

ぜひお試しください。

- 投稿日:2019-12-21T18:14:27+09:00

[Tips]AWS Lambdaにzipファイルアップロードをコマンド一発で行う

前提

- Node.js

- aws-cliインストール済みであること

説明

lambda関数をzipアップロードする場合、zipに固めて管理画面ポチポチするよりも、npm(Node.jsの場合)でスクリプト化しておくと良い。

コード

package.json... "scripts": { "predeploy": "zip -r Lambda.zip * -x *.zip *.json", "deploy": "aws lambda update-function-code --function-name {{ Lambda関数のARN }} fileb://Lambda.zip" }, ...実行

npm run deploy補足

npm-scriptsの「pre」プレフィックスを付けると、特定のコマンドの前に自動で実行される。

なので、上の例でpredeployを直接実行する必要はない。

「post」プレフィックスも同様で、事後処理を入れたい場合に使う。まとめ

デプロイは何度も行うことになるので、トータルで見ると時間短縮につながると思います。

- 投稿日:2019-12-21T17:07:53+09:00

【AWS SAM】Python版入門

内容

samがアップデートされて使いやすくなったらしいので、Pipenvでの環境構築からデプロイまでの流れを備忘録として残しておこうと思います。

環境

- macOS Mojave -10.14

- python3.7.4

- sam 0.38.0

目次

- Pipenvで環境構築

- アプリケーションの初期化

- デプロイ

1. Pipenvで環境構築

Pipenvインストール

$ pip install pipenvPipenv初期化

$ pipenv --python 3.7仮想環境に入る

$ pipenv shellaws-sam-cliインストール

開発時に必要なライブラリは

--devオプションをつけることで別枠に出来ます$ pipenv install aws-sam-cli --dev2. アプリケーションの初期化

この後の作業のため、

Project name [sam-app]:はpipfile等があるディレクトリと同じ名前にしましょう。テンプレートアプリケーションの生成

$ sam init Which template source would you like to use? 1 - AWS Quick Start Templates 2 - Custom Template Location Choice: 1 Which runtime would you like to use? 1 - nodejs12.x 2 - python3.8 3 - ruby2.5 4 - go1.x 5 - java11 6 - dotnetcore2.1 7 - nodejs10.x 8 - nodejs8.10 9 - python3.7 10 - python3.6 11 - python2.7 12 - java8 13 - dotnetcore2.0 14 - dotnetcore1.0 Runtime: 9 Project name [sam-app]: aws-sam-1 Allow SAM CLI to download AWS-provided quick start templates from Github [Y/n]: y AWS quick start application templates: 1 - Hello World Example 2 - EventBridge Hello World 3 - EventBridge App from scratch (100+ Event Schemas) Template selection: 1 ----------------------- Generating application: ----------------------- Name: sam-app Runtime: python3.7 Dependency Manager: pip Application Template: hello-world Output Directory: . Next steps can be found in the README file at ./aws-sam-1/README.mdここまでの作業で、ディレクトリ構成はこのようになっているハズです。

. ├── Pipfile ├── Pipfile.lock ├── README.md └── aws-sam-1 ├── README.md ├── events │ └── event.json ├── hello_world │ ├── __init__.py │ ├── app.py │ └── requirements.txt ├── template.yaml └── tests └── unit ├── __init__.py └── test_handler.pyただ、フラットな方がいいのいで

aws-sam-1/以下を一つ上の階層に持ってきます。$ mv ./aws-sam-1/* ./ $ rm -r ./aws-sam-1実行後のディレクトリ階層はこんな感じです。

1リポジトリで複数テンプレートを管理することってあまり無いので、こちらの方がスッキリしていて好きです。. ├── Pipfile ├── Pipfile.lock ├── README.md ├── events │ └── event.json ├── hello_world │ ├── __init__.py │ ├── app.py │ └── requirements.txt ├── template.yaml └── tests └── unit ├── __init__.py └── test_handler.pyアプリケーションのビルド

$ sam buildBuilding resource 'HelloWorldFunction' Running PythonPipBuilder:ResolveDependencies Running PythonPipBuilder:CopySource Build Succeeded Built Artifacts : .aws-sam/build Built Template : .aws-sam/build/template.yaml Commands you can use next ========================= [*] Invoke Function: sam local invoke [*] Deploy: sam deploy --guided実行すると、

.aws-sam/以下に色々できます。

詳しくは解説しませんが、実際にデプロイされる実行スクリプトやtemplate.yaml、ライブラリなどです。3. デプロイ

さて、ようやくデプロイですが、アップデートによってここが一番簡単になったと思います。

以前は、毎回

sam packageでソースコードや依存ファイルのアップデート等を行い、デプロイ時にはスタック名も指定しなければならないと、割と面倒でした。

アップデート後は、--guidedオプションをつけることで、それらをsamconfig.tomlというファイルにまとめてくれるようになりました。

これにより、2回目以降のデプロイは、sam deployコマンドのみでOKになります。では、アップデート後のデプロイをやっていきましょう。

~/.aws/credentialsで設定を分けている方は、--profileオプションを付けてください。デプロイ