- 投稿日:2020-07-04T22:44:28+09:00

AWS App2Container で既存アプリケーションをコンテナ化しよう

はじめに

2020/7/1 に 既存の.NET および Java アプリケーションをコンテナ化するための

AWS App2Container というツールがリリースされました。AWS App2Container の発表 - アプリケーションをコンテナ化して AWS クラウドに移行する

https://aws.amazon.com/jp/about-aws/whats-new/2020/07/announcing-aws-app2container/AWS App2Container は、起動中アプリケーションとその依存関係をコンテナイメージに

パッケージ化してECS タスクと Kubernetes ポッド定義を生成します。

またこれらをAWS 上にデプロイするための CloudForamtion テンプレートおよび、

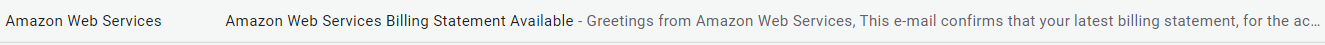

CI/CD パイプライン用のテンプレートまで作成することもできます。AWS App2Container 自体は無料で利用可能で、デプロイする AWS リソースに対し

通常の利用料金が発生します。

Javaアプリケーションのコンテナ化、ECS on Fargate と EKS のデプロイをそれぞれ実施しました。前提条件

Java アプリケーションの場合の環境の前提条件は以下の通りです。

サポートされる Java アプリケーションフレームワーク

- Tomcat

- Spring Boot

- JBoss (standalone mode)

- Weblogic (standalone mode)

- Websphere (standalone mode)

サポートされる Linux ディストリビューション

- Ubuntu

- CentOS

- RHEL

- Amazon Linux

また作業環境が以下の条件を満たしている必要があります。

これらのインストール手順や設定手順は割愛します。

- AWS CLI がインストール済みであること

- Docker Engine のインストール済みであること

- サーバーの root アクセス権があること

- tar コマンドが利用可能であること

- ストレージに 20GB 以上の空き容量があること

IAM ユーザー必要な権限は以下のドキュメントに記載されています。

コンテナ化したアプリケーションをデプロイする際には、AdministratorAccess が

前提となっているようです。App2ContainerでのIDおよびアクセス管理

https://docs.aws.amazon.com/app2container/latest/UserGuide/iam-a2c.html今回は Amazon Linux 2 上に Spring Boot アプリケーションを起動し、検証しました。

アプリケーションの準備

Spring Boot CLI を使用して Hello World アプリケーションを準備します。

手順は以下に記載のある通りです。

https://spring.pleiades.io/spring-boot/docs/current/reference/html/spring-boot-cli.htmlhello.groovy@RestController class WebApplication { @RequestMapping("/") String home() { "Hello World!" } }アプリケーションを起動し、

$ spring run hello.groovy正常に応答することを確認しておきます。

$ curl localhost:8080 Hello World!App2Container のインストール

インストール

インストールパッケージをダウンロードし、展開します。

$ curl -o AWSApp2Container-installer-linux.tar.gz https://app2container-release-us-east-1.s3.us-east-1.amazonaws.com/latest/linux/AWSApp2Container-installer-linux.tar.gz % Total % Received % Xferd Average Speed Time Time Time Current Dload Upload Total Spent Left Speed 100 104M 100 104M 0 0 8360k 0 0:00:12 0:00:12 --:--:-- 9605k $ sudo tar xvf AWSApp2Container-installer-linux.tar.gz install.sh README termsandconditions.txt security/ security/app2container.sig security/app2container.cert AWSApp2Container.tar.gzinstall.sh を実行します。

利用規約への同意が必要です。$ sudo ./install.sh Determining user ... Determining Installer Path ... The AWS App2Container tool is licensed as "AWS Content" under the terms and conditions of the AWS Customer Agreement, located at https://aws.amazon.com/agreement and the Service Terms, located at https://aws.amazon.com/service-terms. By installing, using or accessing the AWS App2Container tool, you agree to such terms and conditions. The term "AWS Content" does not include software and assets distributed under separate license terms (such as code licensed under an open source license). Do you accept the terms and conditions above? (y/n): y Installing AWS App2Container ... ~~以降省略~~ Installation of AWS App2Container completed successfully! You are currently running version 1.0.0. To get started, run 'sudo app2container init' AWS App2Container was installed under /usr/local/app2container/AWSApp2Container.正常にインストールされたことを確認します。

$ sudo app2container --version app2container version 1.0.0初期設定

init コマンドで初期設定を行います。

内容は記載のとおりですが、コンテナ化に関連するアーティファクトの格納ディレクトリや

使用する AWS CLI のプロファイルなどが指定できます。

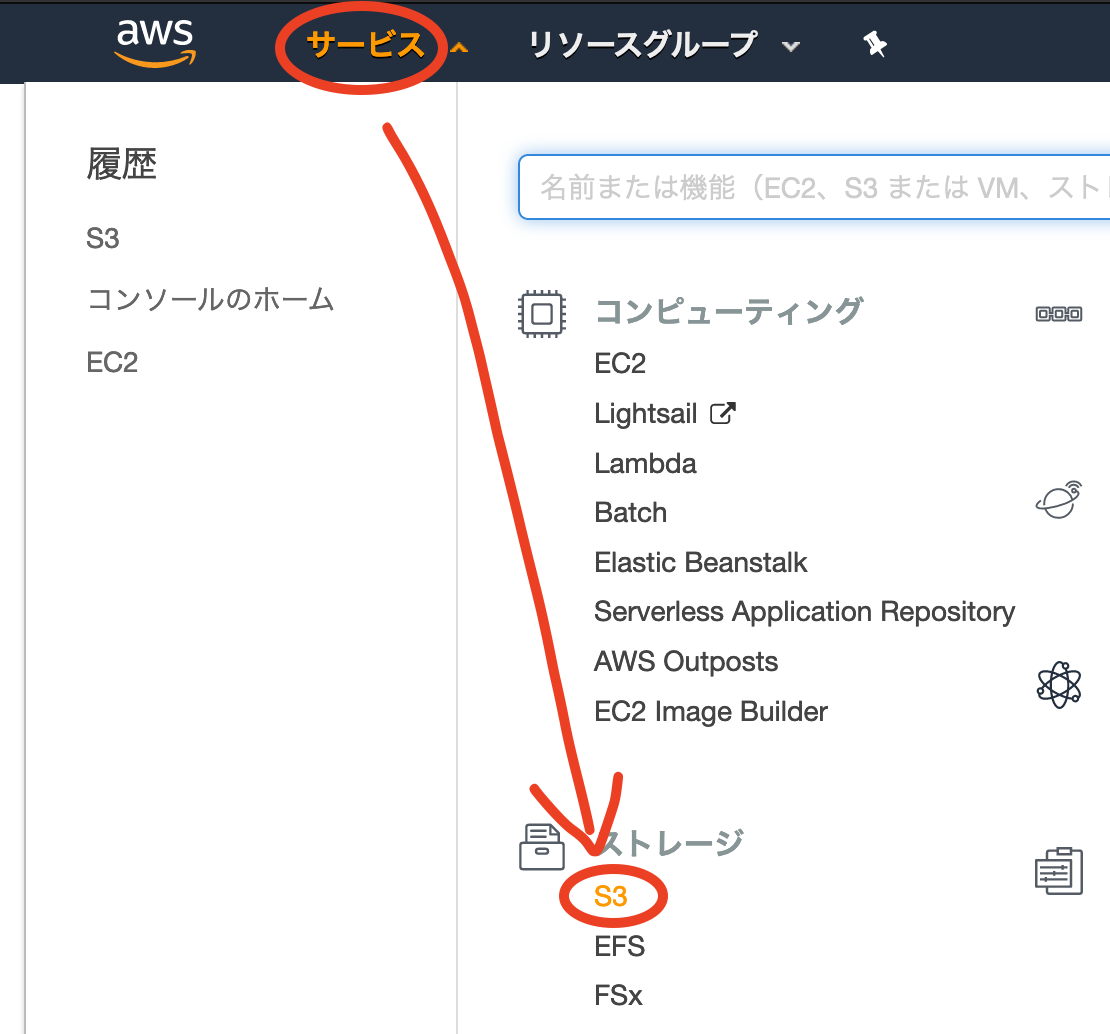

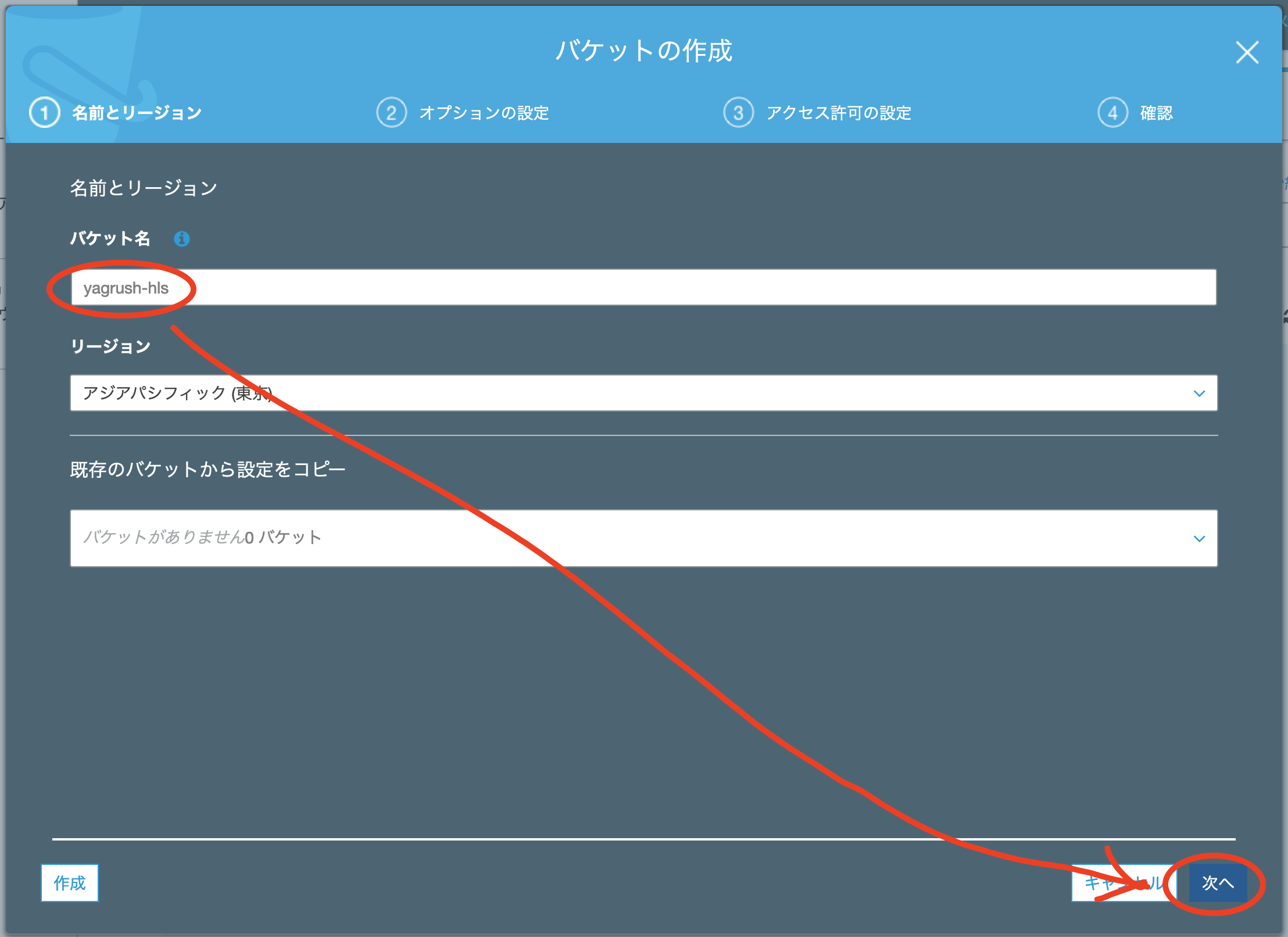

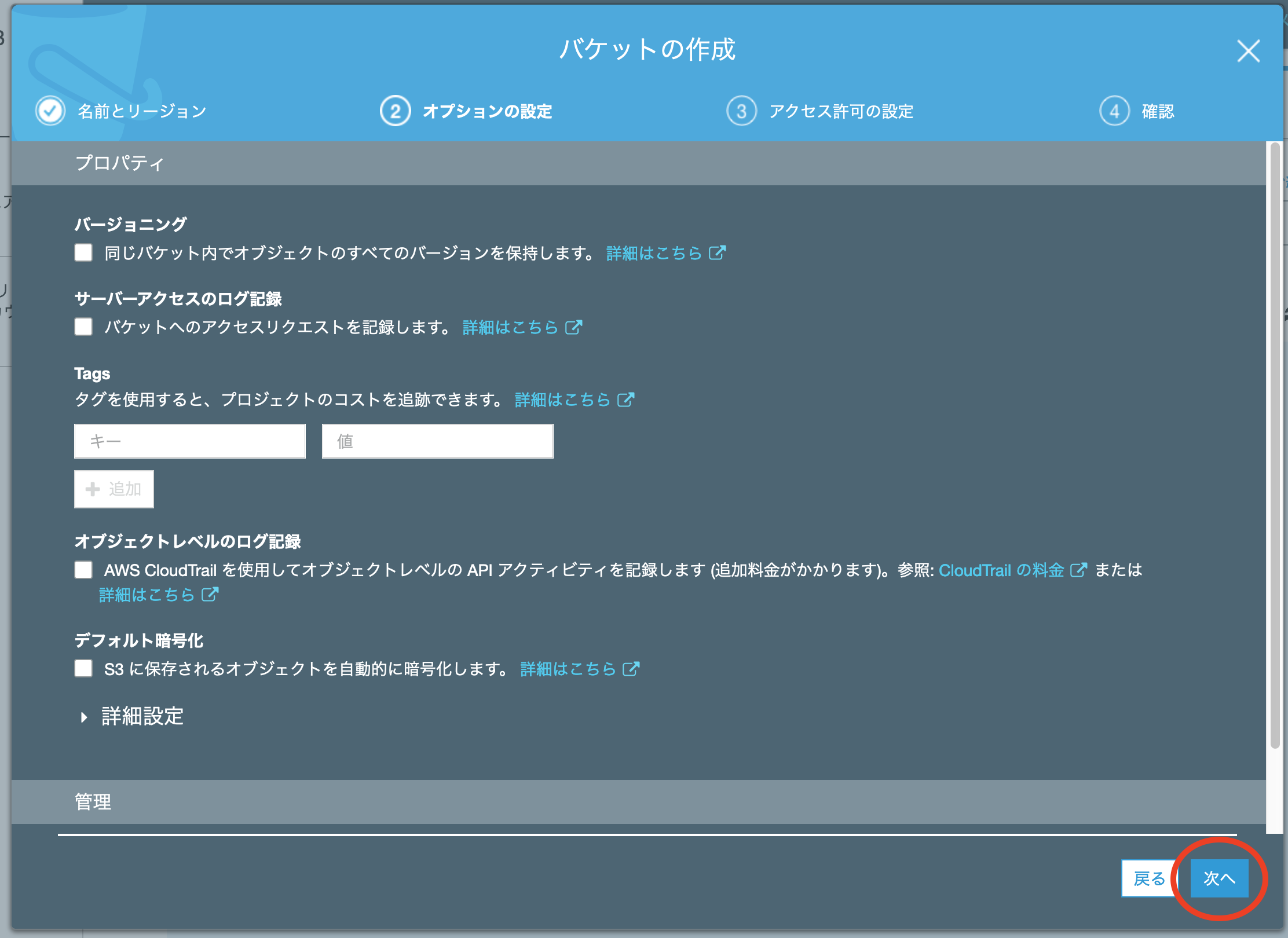

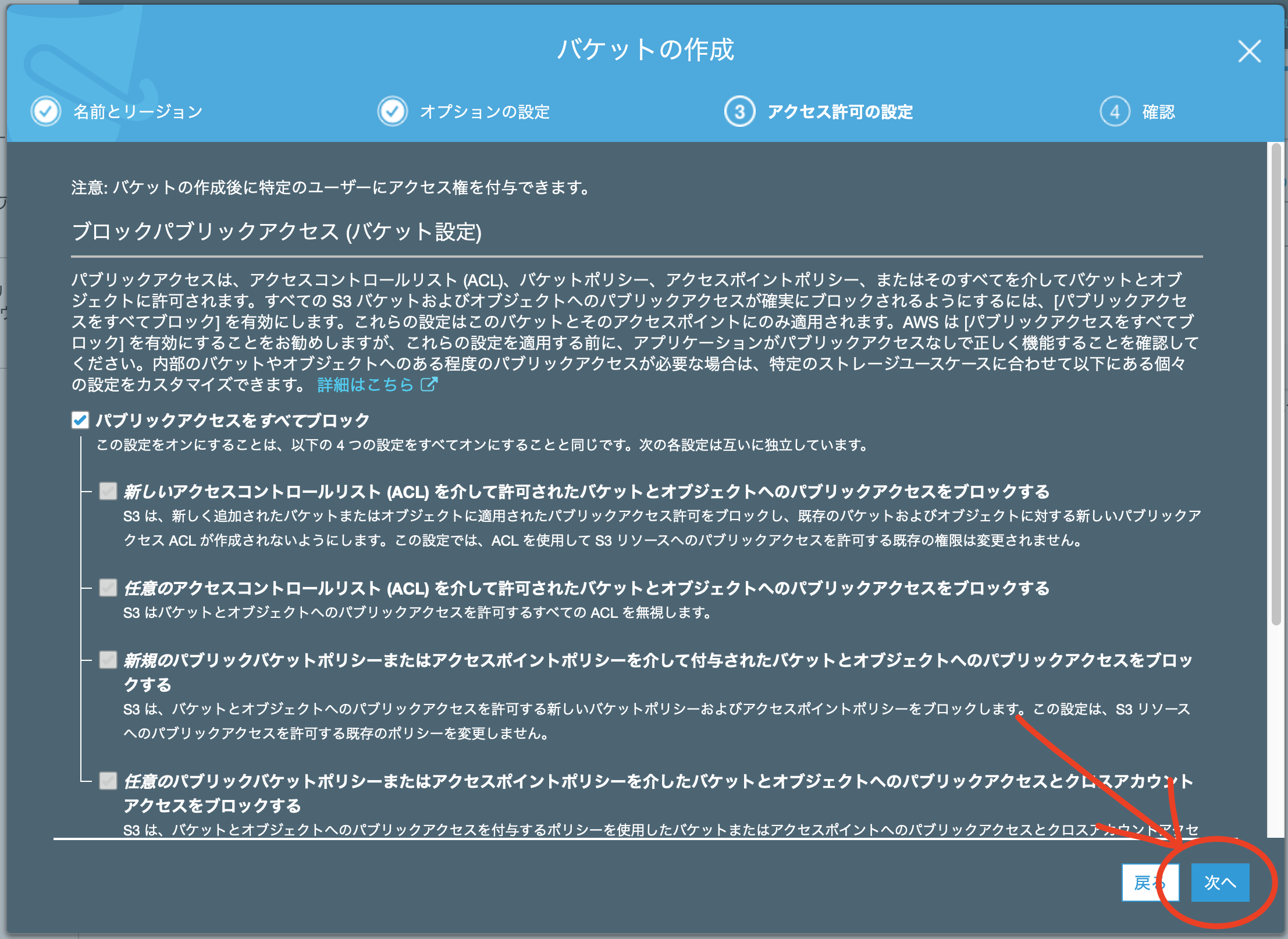

アーティファクトの格納先 S3 バケット(オプション) は App2Container で AWS 環境への

デプロイを行う場合は指定が必要です。$ sudo app2container init Workspace directory path for artifacts[default: /root/app2container]: AWS Profile (configured using 'aws configure --profile')[default: default]: Optional S3 bucket for application artifacts: <your_bucket_name> Report usage metrics to AWS? (Y/N)[default: y]: N Require images to be signed using Docker Content Trust (DCT)? (Y/N)[default: n]: N Configuration savedアプリケーションのコンテナ化

既存アプリケーションの分析

inventory コマンドで実行中のアプリケーションを一覧表示します。

以下の例の場合、java-generic-65424cc9がアプリケーションIDとなり、

後続のコマンド実行時に指定が必要です。$ sudo app2container inventory { "java-generic-65424cc9": { "processId": 2493, "cmdline": "/usr/lib/jvm/java-11-openjdk-11.0.7.10-4.amzn2.0.1.x86_64/bin/java ... /usr/local/bin:/usr/local/lib/spring-boot-cli-2.3.1.RELEASE.jar org.springframework.boot.loader.JarLauncher run ./hello.groovy ", "applicationType": "java-generic" } }analyze コマンドを実行すると、init 時に指定したアーティファクトディレクトリに

analysis.json が保存されます。アプリケーション実行のための依存関係が記述されており、

必要に応じて手動で値を書き換えることもできます。$ sudo app2container analyze --application-id java-generic-65424cc9 ✔ Created artifacts folder /root/app2container/java-generic-65424cc9 ✔ Generated analysis data in /root/app2container/java-generic-65424cc9/analysis.json ? Analysis successful for application java-generic-65424cc9 ? Next Steps: 1. View the application analysis file at /root/app2container/java-generic-65424cc9/analysis.json. 2. Edit the application analysis file as needed. 3. Start the containerization process using this command: app2container containerize --application-id java-generic-65424cc9

analysis.json の例 (クリックで展開)

analysis.json{ "a2CTemplateVersion": "1.0", "createdTime": "2020-07-04 09:31:254", "containerParameters": { "_comment1": "*** EDITABLE: The below section can be edited according to the application requirements. Please see the analysisInfo section below for details discovered regarding the application. ***", "imageRepository": "java-generic-65424cc9", "imageTag": "latest", "containerBaseImage": "amazonlinux:2", "appExcludedFiles": [], "appSpecificFiles": [], "applicationMode": false, "logLocations": [], "enableDynamicLogging": false, "dependencies": [] }, "analysisInfo": { "_comment2": "*** NON-EDITABLE: Analysis Results ***", "processId": 2493, "appId": "java-generic-65424cc9", "userId": "1001", "groupId": "1001", "cmdline": [ "/usr/lib/jvm/java-11-openjdk-11.0.7.10-4.amzn2.0.1.x86_64/bin/java", "-cp", "/usr/local/bin:/usr/local/lib/spring-boot-cli-2.3.1.RELEASE.jar", "org.springframework.boot.loader.JarLauncher", "run", "./hello.groovy" ], "osData": { "ANSI_COLOR": "0;33", "CPE_NAME": "cpe:2.3:o:amazon:amazon_linux:2", "HOME_URL": "https://amazonlinux.com/", "ID": "amzn", "ID_LIKE": "centos rhel fedora", "NAME": "Amazon Linux", "PRETTY_NAME": "Amazon Linux 2", "VERSION": "2", "VERSION_ID": "2" }, "osName": "amzn", "ports": [ { "localPort": 8080, "protocol": "tcp6" } ], "Properties": { "classpath": "/usr/local/bin:/usr/local/lib/spring-boot-cli-2.3.1.RELEASE.jar", "jdkVersion": "11.0.7" }, "AdvancedAppInfo": null, "env": { "HOME": "/home/ssm-user", "JAVA_HOME": "/usr/lib/jvm/java-11-openjdk-11.0.7.10-4.amzn2.0.1.x86_64", "LANG": "C.UTF-8", "OLDPWD": "/usr/local", "PATH": "/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin", "PWD": "/home/ssm-user", "SHLVL": "1", "SPRING_HOME": "/usr/local", "TERM": "xterm-256color" }, "cwd": "/home/ssm-user", "procUID": { "euid": "1001", "suid": "1001", "fsuid": "1001", "ruid": "1001" }, "procGID": { "egid": "1001", "sgid": "1001", "fsgid": "1001", "rgid": "1001" }, "userNames": { "1001": "ssm-user" }, "groupNames": { "1001": "ssm-user" }, "fileDescriptors": [ "/dev/pts/8", "/dev/pts/8", "/dev/pts/8", "/home/ssm-user/.m2/repository/org/springframework/boot/spring-boot-starter/2.3.1.RELEASE/spring-boot-starter-2.3.1.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/boot/spring-boot/2.3.1.RELEASE/spring-boot-2.3.1.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-context/5.2.7.RELEASE/spring-context-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/boot/spring-boot-autoconfigure/2.3.1.RELEASE/spring-boot-autoconfigure-2.3.1.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/boot/spring-boot-starter-logging/2.3.1.RELEASE/spring-boot-starter-logging-2.3.1.RELEASE.jar", "/home/ssm-user/.m2/repository/ch/qos/logback/logback-classic/1.2.3/logback-classic-1.2.3.jar", "/usr/lib/jvm/java-11-openjdk-11.0.7.10-4.amzn2.0.1.x86_64/lib/modules", "/home/ssm-user/.m2/repository/ch/qos/logback/logback-core/1.2.3/logback-core-1.2.3.jar", "/home/ssm-user/.m2/repository/org/slf4j/slf4j-api/1.7.30/slf4j-api-1.7.30.jar", "/home/ssm-user/.m2/repository/org/apache/logging/log4j/log4j-to-slf4j/2.13.3/log4j-to-slf4j-2.13.3.jar", "/home/ssm-user/.m2/repository/org/apache/logging/log4j/log4j-api/2.13.3/log4j-api-2.13.3.jar", "/home/ssm-user/.m2/repository/org/slf4j/jul-to-slf4j/1.7.30/jul-to-slf4j-1.7.30.jar", "/home/ssm-user/.m2/repository/jakarta/annotation/jakarta.annotation-api/1.3.5/jakarta.annotation-api-1.3.5.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-core/5.2.7.RELEASE/spring-core-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-jcl/5.2.7.RELEASE/spring-jcl-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/org/yaml/snakeyaml/1.26/snakeyaml-1.26.jar", "/home/ssm-user/.m2/repository/org/springframework/boot/spring-boot-starter-web/2.3.1.RELEASE/spring-boot-starter-web-2.3.1.RELEASE.jar", "/usr/local/lib/spring-boot-cli-2.3.1.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/boot/spring-boot-starter-json/2.3.1.RELEASE/spring-boot-starter-json-2.3.1.RELEASE.jar", "/home/ssm-user/.m2/repository/com/fasterxml/jackson/core/jackson-databind/2.11.0/jackson-databind-2.11.0.jar", "/home/ssm-user/.m2/repository/com/fasterxml/jackson/core/jackson-annotations/2.11.0/jackson-annotations-2.11.0.jar", "/home/ssm-user/.m2/repository/com/fasterxml/jackson/core/jackson-core/2.11.0/jackson-core-2.11.0.jar", "/home/ssm-user/.m2/repository/com/fasterxml/jackson/datatype/jackson-datatype-jdk8/2.11.0/jackson-datatype-jdk8-2.11.0.jar", "/home/ssm-user/.m2/repository/com/fasterxml/jackson/datatype/jackson-datatype-jsr310/2.11.0/jackson-datatype-jsr310-2.11.0.jar", "/home/ssm-user/.m2/repository/com/fasterxml/jackson/module/jackson-module-parameter-names/2.11.0/jackson-module-parameter-names-2.11.0.jar", "/home/ssm-user/.m2/repository/org/springframework/boot/spring-boot-starter-tomcat/2.3.1.RELEASE/spring-boot-starter-tomcat-2.3.1.RELEASE.jar", "/home/ssm-user/.m2/repository/org/apache/tomcat/embed/tomcat-embed-core/9.0.36/tomcat-embed-core-9.0.36.jar", "/home/ssm-user/.m2/repository/org/glassfish/jakarta.el/3.0.3/jakarta.el-3.0.3.jar", "/home/ssm-user/.m2/repository/org/apache/tomcat/embed/tomcat-embed-websocket/9.0.36/tomcat-embed-websocket-9.0.36.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-web/5.2.7.RELEASE/spring-web-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-beans/5.2.7.RELEASE/spring-beans-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-webmvc/5.2.7.RELEASE/spring-webmvc-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-aop/5.2.7.RELEASE/spring-aop-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-expression/5.2.7.RELEASE/spring-expression-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/org/codehaus/groovy/groovy-templates/2.5.12/groovy-templates-2.5.12.jar", "/home/ssm-user/.m2/repository/org/codehaus/groovy/groovy/2.5.12/groovy-2.5.12.jar", "/home/ssm-user/.m2/repository/org/codehaus/groovy/groovy/2.5.12/groovy-2.5.12.jar", "/home/ssm-user/.m2/repository/org/codehaus/groovy/groovy-xml/2.5.12/groovy-xml-2.5.12.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-context/5.2.7.RELEASE/spring-context-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/boot/spring-boot/2.3.1.RELEASE/spring-boot-2.3.1.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/boot/spring-boot-autoconfigure/2.3.1.RELEASE/spring-boot-autoconfigure-2.3.1.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-beans/5.2.7.RELEASE/spring-beans-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/jakarta/annotation/jakarta.annotation-api/1.3.5/jakarta.annotation-api-1.3.5.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-web/5.2.7.RELEASE/spring-web-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/boot/spring-boot-starter/2.3.1.RELEASE/spring-boot-starter-2.3.1.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/boot/spring-boot-starter-logging/2.3.1.RELEASE/spring-boot-starter-logging-2.3.1.RELEASE.jar", "/home/ssm-user/.m2/repository/ch/qos/logback/logback-classic/1.2.3/logback-classic-1.2.3.jar", "/home/ssm-user/.m2/repository/ch/qos/logback/logback-core/1.2.3/logback-core-1.2.3.jar", "/home/ssm-user/.m2/repository/org/slf4j/slf4j-api/1.7.30/slf4j-api-1.7.30.jar", "/home/ssm-user/.m2/repository/org/apache/logging/log4j/log4j-to-slf4j/2.13.3/log4j-to-slf4j-2.13.3.jar", "/home/ssm-user/.m2/repository/org/apache/logging/log4j/log4j-api/2.13.3/log4j-api-2.13.3.jar", "/home/ssm-user/.m2/repository/org/slf4j/jul-to-slf4j/1.7.30/jul-to-slf4j-1.7.30.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-core/5.2.7.RELEASE/spring-core-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-jcl/5.2.7.RELEASE/spring-jcl-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/org/yaml/snakeyaml/1.26/snakeyaml-1.26.jar", "/home/ssm-user/.m2/repository/org/springframework/boot/spring-boot-starter-web/2.3.1.RELEASE/spring-boot-starter-web-2.3.1.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/boot/spring-boot-starter-json/2.3.1.RELEASE/spring-boot-starter-json-2.3.1.RELEASE.jar", "/home/ssm-user/.m2/repository/com/fasterxml/jackson/core/jackson-databind/2.11.0/jackson-databind-2.11.0.jar", "/usr/local/lib/spring-boot-cli-2.3.1.RELEASE.jar", "/home/ssm-user/.m2/repository/com/fasterxml/jackson/core/jackson-annotations/2.11.0/jackson-annotations-2.11.0.jar", "/home/ssm-user/.m2/repository/com/fasterxml/jackson/core/jackson-core/2.11.0/jackson-core-2.11.0.jar", "/home/ssm-user/.m2/repository/com/fasterxml/jackson/datatype/jackson-datatype-jdk8/2.11.0/jackson-datatype-jdk8-2.11.0.jar", "/home/ssm-user/.m2/repository/com/fasterxml/jackson/datatype/jackson-datatype-jsr310/2.11.0/jackson-datatype-jsr310-2.11.0.jar", "/home/ssm-user/.m2/repository/com/fasterxml/jackson/module/jackson-module-parameter-names/2.11.0/jackson-module-parameter-names-2.11.0.jar", "/home/ssm-user/.m2/repository/org/springframework/boot/spring-boot-starter-tomcat/2.3.1.RELEASE/spring-boot-starter-tomcat-2.3.1.RELEASE.jar", "/home/ssm-user/.m2/repository/org/apache/tomcat/embed/tomcat-embed-core/9.0.36/tomcat-embed-core-9.0.36.jar", "/home/ssm-user/.m2/repository/org/glassfish/jakarta.el/3.0.3/jakarta.el-3.0.3.jar", "/home/ssm-user/.m2/repository/org/apache/tomcat/embed/tomcat-embed-websocket/9.0.36/tomcat-embed-websocket-9.0.36.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-webmvc/5.2.7.RELEASE/spring-webmvc-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-aop/5.2.7.RELEASE/spring-aop-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/org/springframework/spring-expression/5.2.7.RELEASE/spring-expression-5.2.7.RELEASE.jar", "/home/ssm-user/.m2/repository/org/codehaus/groovy/groovy-templates/2.5.12/groovy-templates-2.5.12.jar", "/home/ssm-user/.m2/repository/org/codehaus/groovy/groovy-xml/2.5.12/groovy-xml-2.5.12.jar" ], "dependencies": {} }

コンテナ化

containerize コマンドでアプリケーションをコンテナ化できます。

この際、AWS CLI に適切なクレデンシャル情報が設定されている必要があります。

(sudo で実行する場合、root ユーザーに設定されたプロファイル)

現在のところ、EC2 でインスタンスプロファイルを設定している場合でも、IAM ロールの

一時クレデンシャルは使用されないようですので、アクセスキーを別途設定しています。$ sudo app2container containerize --application-id java-generic-65424cc9 ✔ AWS prerequisite check succeeded ✔ Docker prerequisite check succeeded ✔ Extracted container artifacts for application ✔ Entry file generated ✔ Dockerfile generated under /root/app2container/java-generic-65424cc9/Artifacts ✔ Generated dockerfile.update under /root/app2container/java-generic-65424cc9/Artifacts ✔ Generated deployment file at /root/app2container/java-generic-65424cc9/deployment.json ? Containerization successful. Generated docker image java-generic-65424cc9 ? You're all set to test and deploy your container image. Next Steps: 1. View the container image with "docker images" and test the application. 2. When you're ready to deploy to AWS, please edit the deployment file as needed at /root/app2container/java-generic-65424cc9/deployment.json. 3. Generate deployment artifacts using "app2container generate app-deployment --application-id java-generic-65424cc9"containerize コマンドにより generate app-deployment コマンド実行時に必要な

deployment.json や Dockerfile、コンテナイメージなどが生成されます。$ sudo tree /root/app2container/java-generic-65424cc9/ /root/app2container/java-generic-65424cc9/ ├── Artifacts │ ├── ContainerFiles.tar ★アプリケーション実行の依存関係をまとめた tar │ ├── Dockerfile │ ├── Dockerfile.update ★ 作成されたイメージをベースイメージとした Dockerfile のサンプル │ ├── entryfile ★ コンテナ起動時の CMD │ └── excludedFiles ★ コンテナ化時に除外されたファイルのリスト ├── analysis.json └── deployment.json

Dockerfile の例 (クリックで展開)

FROM amazonlinux:2 MAINTAINER AWS WORKDIR / # Copying Entryfile COPY entryfile /entryfile # Pre install packages RUN yum -y install tar && yum -y install gzip && yum -y install shadow-utils.x86_64 # Adding and unpacking Tar file COPY ContainerFiles.tar / RUN tar xvfP /ContainerFiles.tar --directory / --skip-old-files --same-owner --ignore-failed-read && rm -rf /ContainerFiles.tar # Follow the below example to update files# COPY ["generic_config_file", "/root/app2container/java-generic-65424cc9/Artifacts/generic_config_file"]# Environment Variables ENV HOME /home/ssm-user ENV JAVA_HOME /usr/lib/jvm/java-11-openjdk-11.0.7.10-4.amzn2.0.1.x86_64 ENV PWD /home/ssm-user ENV TERM xterm-256color ENV LANG C.UTF-8 ENV OLDPWD /usr/local ENV PATH /usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin ENV SHLVL 1 ENV SPRING_HOME /usr/local # Exposing ports EXPOSE 8080 # User and user group RUN groupadd -f -r -g 1001 ssm-user RUN id -u ssm-user > /dev/null 2>&1 || useradd -r -g 1001 -u 1001 ssm-user USER ssm-user:ssm-user WORKDIR /home/ssm-user # Image Entrypoint CMD /entryfile

deployment.json についても 手動で編集することが可能です。

ECS のパラメーターについて、デフォルトで cpu:2, memory:4096 が設定されており、

Fargate タスク実行時のリソースとして確保されるようですので、必要に応じて変更すべきかと思います。

deployment.json の例 (クリックで展開)

deployment.json{ "a2CTemplateVersion": "1.0", "applicationId": "java-generic-65424cc9", "imageName": "java-generic-65424cc9", "exposedPorts": [ { "localPort": 8080, "protocol": "tcp6" } ], "environment": [], "ecrParameters": { "ecrRepoTag": "latest" }, "ecsParameters": { "createEcsArtifacts": true, "ecsFamily": "java-generic-65424cc9", "cpu": 2, "memory": 4096, "dockerSecurityOption": "", "enableCloudwatchLogging": false, "publicApp": true, "stackName": "a2c-java-generic-65424cc9-ECS", "reuseResources": { "vpcId": "", "cfnStackName": "", "sshKeyPairName": "" }, "gMSAParameters": { "domainSecretsArn": "", "domainDNSName": "", "domainNetBIOSName": "", "createGMSA": false, "gMSAName": "" } }, "eksParameters": { "createEksArtifacts": false, "stackName": "a2c-java-generic-65424cc9-EKS", "reuseResources": { "vpcId": "", "cfnStackName": "", "sshKeyPairName": "" } } }[

この時点で コンテナイメージが作成されているため、ローカルで実行して検証することもできます。

現在稼働中の環境を再現するためだとはおもいますが、なかなかのイメージサイズになってます。$ sudo docker image ls REPOSITORY TAG IMAGE ID CREATED SIZE java-generic-65424cc9 latest d7843b85b3b9 About an hour ago 3.95GB amazonlinux 2 fa0a6a710ca7 3 days ago 163MB $ sudo docker run --rm -d -p 8080:8080 java-generic-65424cc9:latest 34e6266424e130f0b6fcb6213547cc7b744123b24805db37bea3e4da9edc094c $ sudo docker ps CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 34e6266424e1 java-generic-65424cc9:latest "/bin/sh -c /entryfi…" 6 seconds ago Up 5 seconds 0.0.0.0:8080->8080/tcp vigilant_lederberg $ curl http://localhost:8080 Hello World!アプリケーションのデプロイ

デプロイ用リソース作成

generate app-deployment コマンドで、アプリケーションを AWS にデプロイするための

CloudFormation テンプレート等の各種リソースが生成されます。

--deployオプションを付与することで、そのままデプロイまで実行できますが、

ここではまずはアーティファクトの生成のみを実行します。$ sudo app2container generate app-deployment --application-id java-generic-65424cc9 ✔ AWS prerequisite check succeeded ✔ Docker prerequisite check succeeded ✔ Created ECR Repository ✔ Registered ECS Task Definition with ECS ✔ Uploaded CloudFormation resources to S3 Bucket: <your_bucket_name> ✔ Generated CloudFormation Master template at: /root/app2container/java-generic-65424cc9/EcsDeployment/ecs-master.yml ? ECS CloudFormation templates and additional deployment artifacts generated successfully for application java-generic-65424cc9 ? You're all set to use AWS CloudFormation to manage your application stack. Next Steps: 1. Edit the CloudFormation template as necessary. 2. Create an application stack using the AWS CLI or the AWS Console. AWS CLI command: aws cloudformation deploy --template-file /root/app2container/java-generic-65424cc9/EcsDeployment/ecs-master.yml --capabilities CAPABILITY_NAMED_IAM --stack-name a2c-java-generic-65424cc9-ECS 3. Set up a pipeline for your application stack using "app2container: app2container generate pipeline --application-id java-generic-65424cc9"実行が成功すると、アーティファクトディレクトリに ECS をデプロイするための

タスク定義、CloudFormation のマスターテンプレート、パイプライン用定義ファイルが配置されます。

EKS 用のリソースはデフォルトでは作成されませんので、記事後半を参照ください。CloudFormation ではネストされたスタックが生成されるため、残りのテンプレートは init 時に

指定した S3 バケットにアップロードされています。$ sudo tree /root/app2container/java-generic-65424cc9/ /root/app2container/java-generic-65424cc9/ ├── Artifacts │ ├── ContainerFiles.tar │ ├── Dockerfile │ ├── Dockerfile.update │ ├── entryfile │ └── excludedFiles ├── EcsDeployment │ └── ecs-master.yml ★ CloudForamtion テンプレート ├── analysis.json ├── deployment.json ├── pipeline.json ★ パイプライン作成用定義ファイル └── taskDef.json ★ ECS用タスク定義 $ aws s3 ls s3://<your_bucket_name>/a2c-<application-id>/ecs/subtemplates/ 2020-07-04 11:58:23 12258 ecs-cluster.yml 2020-07-04 11:58:23 2327 ecs-dns.yml 2020-07-04 11:58:24 16521 ecs-gmsa-automation-doc.yml 2020-07-04 11:58:24 2545 ecs-gmsa-execute.yml 2020-07-04 11:58:24 7216 ecs-gmsa-iam-roles.yml 2020-07-04 11:58:24 6112 ecs-gmsa-lambda-functions.yml 2020-07-04 11:58:24 3713 ecs-gmsa.yml 2020-07-04 11:58:24 16909 ecs-lb-webapp.yml 2020-07-04 11:58:24 19955 ecs-master.yml 2020-07-04 11:58:24 10882 ecs-private-app.yml 2020-07-04 11:58:24 9586 ecs-public-load-balancer.yml 2020-07-04 11:58:24 3377 ecs-vpc.ymlまた、この時点で ECS へのタスク定義登録および、ECR へのイメージ push が自動で行われています。

ECS on Fargate へのデプロイ

generate app-deployment コマンドで生成された ecs-master.yml を使用してデプロイします。

$ sudo aws cloudformation deploy --template-file /root/app2container/java-generic-65424cc9/EcsDeployment/ecs-master.yml --capabilities CAPABILITY_NAMED_IAM --stack-name a2c-java-generic-65424cc9-ECS Waiting for changeset to be created.. Waiting for stack create/update to complete Successfully created/updated stack - a2c-java-generic-65424cc9-ECS作成された ELB にリクエストを投げると、メッセージが返ってきました。

$ aws cloudformation describe-stacks --stack-name a2c-java-generic-65424cc9-ECS --query 'Stacks[].Outputs[2]' [ { "ExportName": "a2c-java-generic-65424cc9-ECS-PublicLoadBalancerDNSForCLIOutput", "OutputKey": "PublicLoadBalancerDNSName", "OutputValue": "a2c-j-Publi-XXXXXXXXXXXX-111111111.ap-northeast-1.elb.amazonaws.com" } ] $ curl http://a2c-j-Publi-XXXXXXXXXXXX-111111111.ap-northeast-1.elb.amazonaws.com Hello World!コンテナを前提に作成されたアプリケーションと比較すると、事前の十分な検証が必要で

運用面等々の課題もあるかもしれませんが

数ステップでコンテナ化~ECS on Fargate へのデプロイまで行えるのは非常に魅力的です。CI/CD パイプラインの作成

デプロイ用リソースの作成

generate pipeline を使用すると、AWS CodePipeline で CI/CD パイプラインを作成するために

必要なアーティファクトを生成することができます。

app-deployment と同様に--deployオプションを使用することもできます。generate pipline を実行するには、generate app-deployment で生成された pipeline.json の

releaseInfo に デプロイされた ECS のクラスタ名とサービス名を追記する必要があります。pipeline.json{ "a2CTemplateVersion": "1.0", "sourceInfo": { "CodeCommit": { "repositoryName": "a2c-java-generic-65424cc9-ecs", "branch": "master" } }, "imageInfo": { "image": "123456789012.dkr.ecr.ap-northeast-1.amazonaws.com/java-generic-65424cc9:latest" }, "releaseInfo": { "ECS": { "beta": { "clusterName": "", "serviceName": "", "enabled": false }, "prod": { "clusterName": "a2c-java-generic-65424cc9-ECS-Cluster", "serviceName": "a2c-java-generic-65424cc9-ECS-LBWebAppStack-XXXXXXXXXXXX-Service-YYYYYYYYYYYY", "enabled": true } } } }ここでは prod に先ほどデプロイしたリソースを指定しています。

generate pipeline を実行すると、CodePipline をデプロイするための

CloudFormation と CodeDeploy 用の buildspec.ymlテンプレートが作成されます。$ sudo app2container generate pipeline --application-id java-generic-65424cc9 ✔ Created CodeCommit repository ✔ Generated buildspec file(s) ✔ Generated CloudFormation templates ✔ Committed files to CodeCommit repository ? Pipeline resource template generation successful for application java-generic-65424cc9 ? You're all set to use AWS CloudFormation to manage your pipeline stack. Next Steps: 1. Edit the CloudFormation template as necessary. 2. Create a pipeline stack using the AWS CLI or the AWS Console. AWS CLI command: aws cloudformation deploy --template-file /root/app2container/java-generic-65424cc9/Artifacts/Pipeline/CodePipeline/ecs-pipeline-master.yml --capabilities CAPABILITY_NAMED_IAM --stack-name a2c-java-generic-65424cc9-ecs-pipeline-stack $ sudo tree /root/app2container/java-generic-65424cc9/ /root/app2container/java-generic-65424cc9/ ├── Artifacts │ ├── ContainerFiles.tar │ ├── Dockerfile │ ├── Dockerfile.update │ ├── Pipeline │ │ └── CodePipeline │ │ ├── Dockerfile │ │ ├── buildspec.yml │ │ └── ecs-pipeline-master.yml │ ├── entryfile │ └── excludedFiles ├── EcsDeployment │ └── ecs-master.yml ├── analysis.json ├── deployment.json ├── pipeline.json └── taskDef.jsonパイプラインのデプロイ

ecs-pipeline-master.yml を使用してデプロイします。

こちらもネストされたスタックとしてデプロイされます。$ sudo aws cloudformation deploy --template-file /root/app2container/java-generic-65424cc9/Artifacts/Pipeline/CodePipeline/ecs-pipeline-master.yml --capabilities CAPABILITY_NAMED_IAM --stack-name a2c-java-generic-65424cc9-ecs-pipeline-stack Waiting for changeset to be created.. Waiting for stack create/update to complete Successfully created/updated stack - a2c-java-generic-65424cc9-ecs-pipeline-stackこれにより、Dockerfile および buildspec.yml が CodeCommit で管理された状態となり、

レポジトリへの変更を検知してパイプラインが起動します。

CodeBuild で コンテナイメージの Build & Push および、タスク定義の編集を行い、

ECS クラスターへのデプロイを行なう、パイプラインを簡単に作成することができます。EKS のデプロイ

EKS デプロイ用アーティファクトの作成

EKS 関連のリソースを作成するには containerize コマンドで作成された deployment.json の

eksParameters を編集し、createEksArtifacts を true に変更する必要があります。"eksParameters": { "createEksArtifacts": true, "stackName": "a2c-java-generic-65424cc9-EKS", "reuseResources": { "vpcId": "", "cfnStackName": "", "sshKeyPairName": "" } }再度、generate app-delopyment コマンドを実行します。

pipeline.json は上書きされてしまうので、ご注意ください。$ sudo app2container generate app-deployment --application-id java-generic-65424cc9 ✔ AWS prerequisite check succeeded ✔ Docker prerequisite check succeeded ✔ Created ECR Repository ✔ Uploaded CloudFormation resources to S3 Bucket: <your_bucket_name> ✔ Generated CloudFormation Master template at: /root/app2container/java-generic-65424cc9/EksDeployment/amazon-eks-master.template.yaml ? EKS CloudFormation templates and additional deployment artifacts generated successfully for application java-generic-65424cc9 ? You're all set to use AWS CloudFormation to manage your application stack.You're all set to use AWS CloudFormation to manage your application stack. Next Steps: 1. Edit the CloudFormation template as necessary. 2. Create an application stack using the AWS CLI or the AWS Console. AWS CLI command: aws cloudformation deploy --template-file /root/app2container/java-generic-65424cc9/EksDeployment/amazon-eks-master.template.yaml --capabilities CAPABILITY_NAMED_IAM --stack-name a2c-java-generic-65424cc9-EKS 3. Setup a pipeline for your application stack using app2container: app2container generate pipeline --application-id java-generic-65424cc9EKS クラスターデプロイ用の CloudFormation テンプレートと deployment と service を作成する

ための マニフェストファイル が作成されます。namespace が default だったりするので

こちらも必要に応じてカスタマイズします。$ sudo tree /root/app2container/java-generic-65424cc9/ /root/app2container/java-generic-65424cc9/ ├── Artifacts │ ├── ContainerFiles.tar │ ├── Dockerfile │ ├── Dockerfile.update │ ├── Pipeline │ │ └── CodePipeline │ │ ├── Dockerfile │ │ ├── buildspec.yml │ │ └── ecs-pipeline-master.yml │ ├── entryfile │ └── excludedFiles ├── EcsDeployment │ └── ecs-master.yml ├── EksDeployment ★ │ ├── amazon-eks-master.template.yaml │ └── java-generic-65424cc9.pem ├── analysis.json ├── deployment.json ├── eks_deployment.yaml ★ ├── eks_service.yaml ★ ├── pipeline.json └── taskDef.jsonEKS クラスターへのデプロイ

amazon-eks-master.template.yaml を使用して、EKS クラスターをデプロイします。

そこそこ時間がかかります。$ sudo aws cloudformation deploy --template-file /root/app2container/java-generic-65424cc9/EksDeployment/amazon-eks-master.template.yaml --capabilities CAPABILITY_NAMED_IAM --stack-name a2c-java-generic-65424cc9-EKS Waiting for changeset to be created.. Waiting for stack create/update to complete Successfully created/updated stack - a2c-java-generic-65424cc9-EKSEKS についても CI/CD パイプラインを作成することができますが、

手順は ECS と同様であるため割愛します。参考

App2Container Documenet

https://docs.aws.amazon.com/app2container/latest/UserGuide/what-is-a2c.html以上です。

参考になれば幸いです。

- 投稿日:2020-07-04T21:29:25+09:00

AWS Toolkit for VS Codeのセットアップ

- 投稿日:2020-07-04T21:22:12+09:00

AWS Lambda 待望の RDS Proxy を CloudFormation で作ってみる

2020/06/30、RDS Proxy がプレビューを終了し、ついに GA (正式リリース) となったことが発表されました。

これまでアンチパターンと言われていた、AWS Lambda と RDS との接続について解決策のひとつとなることから、サーバーレス界隈では待望の機能であったと思います。

この記事では、CloudFormation でこの RDS Proxy を作ってみたいと思います。が、その前に、RDS Proxy について少し振り返ってみたいと思います。

RDS Proxy は AWS Lambda にとって何が嬉しいのか

AWS Lambda はいわゆるサーバーレスのサービスです。そのため、常在的に起動しているリソースは基本的にありません。なんらかのイベントが発生したことを契機に、Lambda 上で実装したアプリケーションを動作させるためのリソースがスピンアップするので、例えば HTTP 要求が着信した、特定の時刻になった、というようなイベントごとに、計算リソースが立ち上がります。

そういったサービスの性質上、同時に発生するイベントの数が多くなればなるほど、起動する AWS Lambda の数が増えることになります。500 件同時に HTTP 要求が着信すれば、500 個の AWS Lambda リソースが立ち上がっている可能性もあります。

この性質と、リレーショナルなデータベース製品との相性が、これまではアンチパターンと言われていました。Lambda のリソースは互いに疎なかたちで起動されることから、誤解を恐れずに言えば、立ち上がった Lambda の数だけデータベースとのコネクションが生成されることになり、これは一般的なフレームワークに搭載されている、いわゆる「コネクションプール」の仕組みとは大きく異なっています。

コネクションが多く生成されるほど、データベースサーバー側の消費メモリも増えることになりますが、上記のような Lambda というサービスの性質上、実装のなかでコネクションプールのような仕組みをもたせることはできず、サービスの外にコネクションプールの役割を果たす何らかのレイヤーを置く必要があるということが、容易に想像できるのではないかと思います。

このコネクションプールとしてのレイヤーを提供する役割を果たすのが、今回 GA された RDS Proxy となります。

RDS Proxy の制約

このように、AWS Lambda としては待望のリリースである RDS Proxy ですが、もちろん銀の弾丸というわけではなく、制約を理解して使っていく必要があります。いくつか、注意すべき制約をピックアップしてみます。

- Aurora を含む、RDS for MySQL 5.6 and 5.7、もしくは RDS for PostgreSQL 10.11 and 11.5 に対応しており、RDS MySQL 8.0 や RDS Oracle などの DB エンジンでは利用できない

- 自身で EC2 インスタンス上に構築した RDB と RDS Proxy を接続することはできない

- 書き込み用のインスタンスのみに対応しており、 読み込み専用のインスタンス (リードレプリカ) に対する RDS Proxy は作れない

- Aurora Serverless や Aurora Multi-Master と Proxy を接続することはできない

特に 3. のリードレプリカと Proxy が接続できない制約は、データベースへの読み込みワークロードをスケールできないので、現時点では大きいと思います。そのため、読み込みに関しては、Proxy を通さないエンドポイントを使う必要があります。ここは今後の対応に期待ですね。

CloudFormation で作ってみる

今回は、MySQL 5.7 互換の Aurora クラスターを構築し、RDS Proxy を CloudFormation から作成してみました。Aurora を配置する VPC やサブネットの ID などは、適宜変更したうえでそのまま使えるかと思います。

なお、CDK でも、2020/07/02 にリリースされた v1.49.0 から L2 Construct が追加され、RDS Proxy がかなり簡潔に書けるようになっています。こちらの README に例があるので、こちらも試してみるとよいかもしれません。

AWSTemplateFormatVersion: 2010-09-09 Metadata: AWS::CloudFormation::Interface: ParameterGroups: - Label: default: "Database Configuration" Parameters: - AuroraUserName - AuroraDatabaseName ParameterLabels: AuroraUserName: default: "Master User Name" AuroraDatabaseName: default: "Database Name" Parameters: AuroraUserName: Type: String AllowedPattern: "[a-zA-Z0-9-]+" ConstraintDescription: "must be between 1 to 16 alphanumeric characters." Description: "The database admin account user name, between 1 to 16 alphanumeric characters." MaxLength: 16 MinLength: 1 Default: "root" AuroraDatabaseName: Type: String AllowedPattern: "[a-zA-Z0-9_]+" ConstraintDescription: "must be between 1 to 64 alphanumeric characters." Description: "The database name, between 1 to 64 alphanumeric characters." MaxLength: 64 MinLength: 1 Default: "test" Resources: ### Aurora MySQL のパスワードを生成 ### AuroraMasterPassword: Type: AWS::SecretsManager::Secret Properties: GenerateSecretString: GenerateStringKey: password PasswordLength: 16 SecretStringTemplate: !Sub "{\"username\":\"${AuroraUserName}\"}" ExcludeCharacters: "\"@/\\" AuroraSecretAttachment: Type: AWS::SecretsManager::SecretTargetAttachment Properties: SecretId: !Ref AuroraMasterPassword TargetId: !Ref AuroraCluster TargetType: AWS::RDS::DBCluster ### Aurora MySQL の生成 ### AuroraSecurityGroup: Type: AWS::EC2::SecurityGroup Properties: VpcId: vpc-0123456789abcedfg GroupDescription: "Security Group for Aurora" SecurityGroupIngress: - IpProtocol: tcp SourceSecurityGroupId: !Ref RdsProxySecurityGroup FromPort: 3306 ToPort: 3306 AuroraSubnetGroup: Type: AWS::RDS::DBSubnetGroup Properties: DBSubnetGroupDescription: "Aurora Subnet Group" SubnetIds: - subnet-0123456789abcedfg - subnet-abcdefg0123456789 AuroraClusterParameterGroup: Type: AWS::RDS::DBClusterParameterGroup Properties: Description: "Aurora Cluster Parameter Group" Family: aurora-mysql5.7 Parameters: time_zone: UTC AuroraCluster: Type: AWS::RDS::DBCluster Properties: DatabaseName: !Ref AuroraDatabaseName DBClusterParameterGroupName: !Ref AuroraClusterParameterGroup Engine: aurora-mysql MasterUsername: !Ref AuroraUserName MasterUserPassword: !Sub "{{resolve:secretsmanager:${AuroraMasterPassword}:SecretString:password::}}" DBSubnetGroupName: !Ref AuroraSubnetGroup VpcSecurityGroupIds: - !Ref AuroraSecurityGroup AuroraParameterGroup: Type: AWS::RDS::DBParameterGroup Properties: Description: "Aurora Parameter Group" Family: aurora-mysql5.7 AuroraInstance1: Type: AWS::RDS::DBInstance Properties: DBClusterIdentifier: !Ref AuroraCluster DBInstanceClass: db.t3.small DBParameterGroupName: !Ref AuroraParameterGroup Engine: aurora-mysql ### RDS Proxy の生成 ### ##### RDS Proxy が Aurora へ接続するためのセキュリティグループ ##### RdsProxySecurityGroup: Type: AWS::EC2::SecurityGroup Properties: VpcId: vpc-01234567890abcdefg GroupDescription: "Security Group for RDS Proxy" ##### RDS Proxy が Aurora へ接続するためのパスワードを取得する IAM ロール ##### RdsProxyRole: Type: AWS::IAM::Role Properties: AssumeRolePolicyDocument: Version: 2012-10-17 Statement: - Effect: Allow Principal: Service: rds.amazonaws.com Action: sts:AssumeRole Policies: - PolicyName: AllowGetSecretValue PolicyDocument: Version: 2012-10-17 Statement: - Effect: Allow Action: - secretsmanager:GetSecretValue - secretsmanager:DescribeSecret Resource: !Ref AuroraSecretAttachment RdsProxy: Type: AWS::RDS::DBProxy Properties: DBProxyName: rds-proxy-for-aurora EngineFamily: MYSQL RoleArn: !GetAtt RdsProxyRole.Arn Auth: - AuthScheme: SECRETS SecretArn: !Ref AuroraSecretAttachment IAMAuth: DISABLED VpcSecurityGroupIds: - !Ref RdsProxySecurityGroup VpcSubnetIds: - subnet-0123456789abcedfg - subnet-abcdefg0123456789 RdsProxyTargetGroup: Type: AWS::RDS::DBProxyTargetGroup DependsOn: - AuroraCluster - AuroraInstance1 Properties: DBProxyName: !Ref RdsProxy DBClusterIdentifiers: - !Ref AuroraCluster TargetGroupName: default Outputs: RDSProxyEndpoint: Value: !GetAtt RdsProxy.Endpoint Export: Name: rds-proxy-endpoint AuroraMasterPassword: Value: !Ref AuroraMasterPassword Export: Name: aurora-master-passwordRDS Proxy が Aurora に接続するための接続情報を、認証情報を管理するサービスである Secrets Manager に格納する必要がある点や、RDS Proxy の Target Group を Aurora クラスターおよびインスタンスが立ち上がったあとに作成するよう、DependsOn 句で明示的に指定してあげる必要がある点などが、注意が必要です。

Lambda から利用するときは、最後に Outputs で出力した RDS Proxy の接続エンドポイントを、Lambda の環境変数などにインポートし、認証情報は Secrets Manager から取得するように実装すると良いと思います。

まとめ

CloudFormation で RDS Proxy を作る実例はあまり見かけなかったので、本記事にて取り上げてみました。次回は、実際に RDS Proxy を通した環境と通さない環境で、Lambda から接続してみてパフォーマンスがどう変わるのか、試してみたいと思います。

- 投稿日:2020-07-04T19:39:52+09:00

Rails5.2から導入されたcredentials.yml.encの使い方

Rails5.2では新規アプリを作成した時にconfig/secrets.ymlが生成されず

代わりにconfig/credentials.yml.encが生成されるようになったみたいです。既に本番環境などでRailsの古いバージョンで運用していてRails5.2にアップグレードする場合は

config/secrets.ymlではなく、config/credentials.yml.encの仕組みが使われるみたいです。Rails5.2までは従来のconfig/secrets.ymlを使用するやり方などもあるみたいですが

Rails6アップグレードのことも考えconfig/credentials.yml.encを導入してみましたので

忘備録のために投稿します。1. credentials.yml.encとmaster.keyの生成と設定

credentials.yml.encは直接エディタから編集する事はできないので、ターミナルでエディタを指定して作成、編集する。

$ EDITOR=vim bundle exec credentials:editちなみに、.bash_profileなどに以下のように設定しておけば、EDITOR="vim"の指定は不要になります。

~/.bash_profile $ echo 'export EDITOR="vim"' >> ~/.bash_profile $ source ~/.bash_profile $ bundle exec credentials:edit上記のコマンドを実行すると、config/credentials.yml.encとconfig/master.keyが生成される。

config/master.keyはgitで管理しないため必ず.gitignoreに追加する。.gitignore # Ignore master key for decrypting credentials and more. /config/master.key生成されたconfig/credentials.yml.encを以下のように修正する。

config/credentials.yml.enc # aws: # access_key_id: 123 # secret_access_key: 345 # Used as the base secret for all MessageVerifiers in Rails, including the one protecting cookies. secret_key_base:

- 今回はsecret_keyだけ設定する。AWSの設定は既存のままいくのでコメントアウトのまま

- 上記の画面にawsのaccess_key_idやsecret_access_key、その他APIキーなどを入力すれば暗号化されて保存される

- 環境変数など使用せず、直接入力して問題ない

- シングルクオーテーションやダブルクオーテーションは不要

本番環境ではcredentialを使うので config/environments/production.rb で次の変数にtrueをセットする

config/environments/production.rb config.require_master_key = true2.Capistranoによる自動デプロイ

本番環境のshared/configにmaster.keyを配置しないとデプロイできない。

本番環境のサーバーにscpコマンドなどで、config/master.keyを転送する。$ scp -i ~/.ssh/example.pem config/master.key ec2-user@x.x.x.x:/var/www/AppName/shared/config/master.key ex. /var/www/AppName/shared/config/master.keyもしくは、本番環境サーバーのbashファイルにRAILS_MASTER_KEY環境変数を設定する。

Capistranoは.bash_profileに書いても読み込まれないので、~/.bashrcに記載する必要がある。

config/master.keyをRAILS_MASTER_KEYとしてexportします。つまり、.bashrcに以下のように設定する。~/.bashrc export RAILS_MASTER_KEY='XXXXXXXXXXXXXXXXXXX'次に、config/deploy.rbでデプロイ時の設定ファイルにシンボリックリンクを指定する。

set :linked_files, fetch(:linked_files, []).push('config/master.key')3.Capistranoを使ってデプロイできれば完了。

$ bundle exec cap production deploy

- 投稿日:2020-07-04T19:06:53+09:00

PHPでAWS S3 の大きいファイルの読込

やりたいこと

- amazon s3 から大きめのファイルをダウンロードしたい

- いちどに取得しよとすると大変そうなので少しずつ取得したい。

- PHP で取得を行う

接続情報を準備する

define('S3', [ 'KEY' => AWSのS3のKEYを設定する, 'PASS' => AWSのS3のパスワードを設定する, 'DIR' => AWSのS3のディレクトリを設定する(s3://<bucket>[/<key-or-prefix>])) ]);接続を行う

AWS SDK for PHPを使用して接続するAmazon S3 ストリームラッパーを使用して接続操作を行うrequire_once 'aws/vendor/autoload.php'; // S3 接続を行う $s3 = S3Client::factory([ 'credentials' => [ 'key' => S3['KEY'], 'secret' => S3['PASS'], ], 'region' => 'ap-northeast-1', 'version' => 'latest', ]); $s3->registerStreamWrapper();

- 関数は

registerStreamWrappeを使用するregisterStreamWrapperを使用すると、ファイルの操作と同じく S3 にアップされているファイルを操作できる。操作を行う

- たとえば、指定しファイルがあるか確認を行う

$readFileName = S3['DIR'].'/確認したいファイル名.XX'; if(file_exists($readFileName)) { echo 'ファイルあり'; }

- たとえば、

freadを使用して読み込みを行う$readFileName = S3['DIR'].'/読み込みたいファイル名.XX'; $fp = fopen($readFileName, "r"); while(!feof($fp)) { $file = fread($fp, 4096); } close($fp);

- 上記のことからわかるように、接続後一般的なファイル操作で S3 のファイルを操作できる。

- 投稿日:2020-07-04T19:03:06+09:00

AzureAD SAML SSOを使うときの SAMLRequestを生成する

前提

- SAML初心者です

- 全体的によくわかってないけれどやってみた結果をまとめてみました

- ちょっと冗長です

経緯

- AzureADをIDプロバイダ(IdP)、AWSをサービスプロバイダ(SP)として使う設定をします

- Microsoftのチュートリアル に沿って設定しました

- https://myapps.microsoft.com へアクセスし、Azureログインした上で、AWSアイコンをクリックすると、AWSへ設定したロールでアクセスできました

- IdP側に各SPへのメニューがあるので、これで使えるのでまあ問題ないと思うのですが、サインオンしていない状態でSPにアクセスした場合はどうするのでしょう

調べる

- サインオンしていない場合はIdPへリダイレクトするのが標準のようです

- 実際そういうサービスはよく見かけます

- 「SP-Initiated SSO」と言うようです

- SP側から「AuthnRequest」を持ってIdPへリダイレクトするらしいです

- 「AuthnRequest」ってなんでしょう...ありました シングル サインオンの SAML プロトコル

- 必要な情報をXMLに詰め込んだモノみたいです。これをどうやって連携しつつIdPへリダイレクトするのでしょう...

- IdPのsaml2受付URLへGETパラメータ

SAMLRequestで指定するようです

https://idp.example.com/saml2?SAMLRequest=連携情報- GETパラメータにXMLそのまま載せられないですよね。どうするんだろう...

- みつけました 「DeflateしてBase64エンコードしてURLエンコードする」難易度高いな...

- Deflateは圧縮ですね.とりあえずpythonで試すので zlib でできそうです

- 圧縮結果はバイナリなのでbase64でエンコードしてGETパラメータに乗せるのでURLエンコードするってことみたいです

- 途中で気づいたのですが、Deflateは「ヘッダとチェックサムを含めない」という指定がありました

zlib.compress()だとヘッダ、チェックサムが付加されるのでzlib.compressobj(wbits=)を使えば良さそうですSP-Initiated SSOをやってみる

SAMLRequestに指定する文字列を生成する

- AuthnRequest XML → Deflate → base64 → urlエンコードして、printしています

get_saml_request_param.pyimport datetime import zlib from base64 import b64encode from urllib import parse def build_saml_request(request_id, issuer): issue_instant=datetime.datetime.utcnow().isoformat(timespec='milliseconds') # 現在時刻でいいかな return f''' <samlp:AuthnRequest xmlns="urn:oasis:names:tc:SAML:2.0:metadata" ID="{request_id}" Version="2.0" IsPassive="false" ForceAuthn="false" IssueInstant="{issue_instant}Z" xmlns:samlp="urn:oasis:names:tc:SAML:2.0:protocol"> <Issuer xmlns="urn:oasis:names:tc:SAML:2.0:assertion">{issuer}</Issuer> </samlp:AuthnRequest>''' def deflate(text): compressobj = zlib.compressobj(wbits=-zlib.MAX_WBITS) return compressobj.compress(text.encode()) + compressobj.flush() def get_saml_request_param(text): return parse.quote_plus(b64encode(deflate(text))) saml_request_text = build_saml_request( request_id='id356a192b7913b04c54574d18c28d46e6395428ab', # 実際はハッシュとかにするのかな issuer='https://signin.aws.amazon.com/saml') # Identifier (Entity ID) print(get_saml_request_param(saml_request_text))

request_idは適当(ただし英字から始める必要あり)issuerはAzure側のSAML SSO設定の値Identifier (Entity ID)を使います

- 実行すると下記のようになります

- 出力された長い文字列を使います

$ python get_saml_request_param.py jZFNS8NAEIbv%2FRVh7002X226JIWgCIUK0loP3qab0S5kd%2BPOpoq%2F3hotGgR1jgPvxzwzCT6nJNBtJ%2BreH8wGn3okH7zo1lDFemeEBVIkDGgk4aXY1tdrkYRcaPTQgAc2Cb7N6rJiqknzGcSLZD9fxOmeZzLP8nnWxIVMiiab4Sxd5FlSwJ4Fd%2BhIWVOxkyULVnQDROqIFXuAlpAFV9ZJHKqdV%2BM4oh5XhjwYf%2FLgCZ%2Fy%2BZRnt7wQeSziIuR5ej%2FW1ETo%2FCn0whrqNbotuqOSuNusK3bwviMRRaQejTIhPFMIGl6tCaXV0TupsdkASgwEf8fVOeuttC1bjvTlcIH7D3A492bLv1uW0YfxV1oZ%2Ffzz8g0%3Dブラウザからテストしてみる

- GETすればいいので、URLを組み立てればブラウザで確認できますね

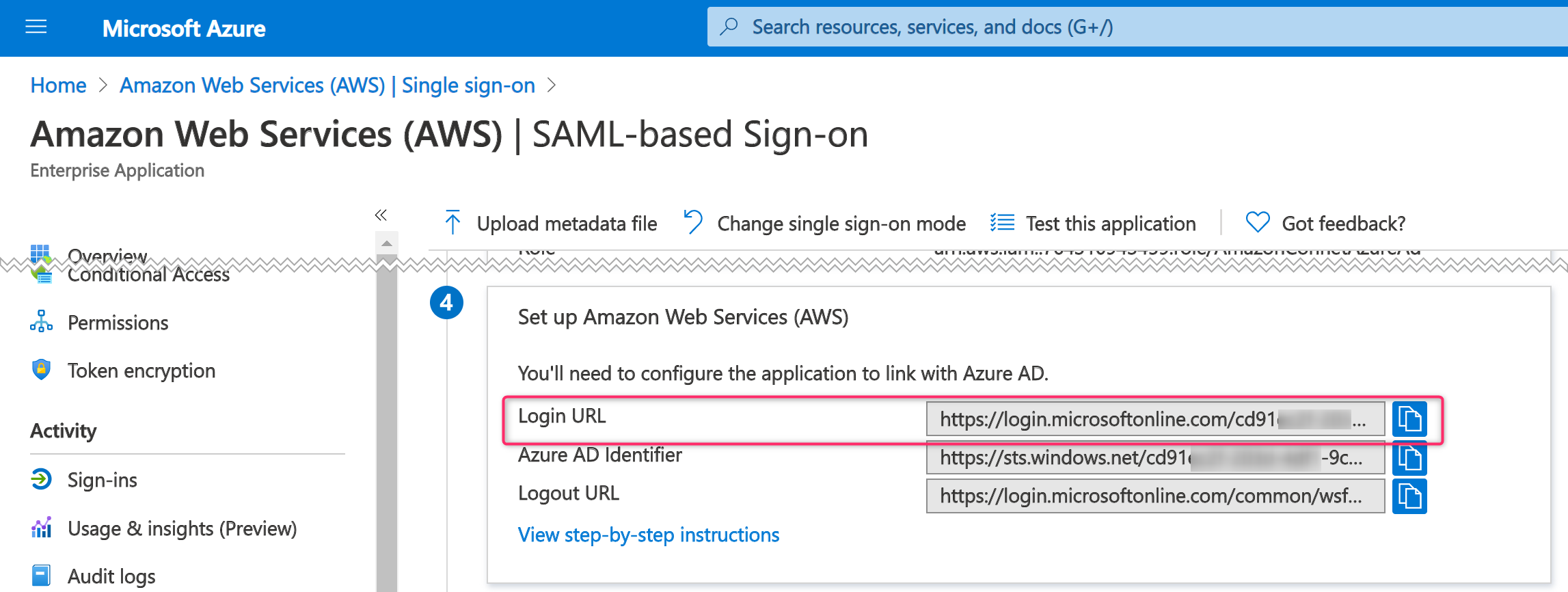

- Azure側のSAML SSO設定ページの

Login URLを使いますURLはこんな感じです(もっと長い)

https://login.microsoftonline.com/cd91xxxxxxxxxxxx/saml2上で生成したSAMLRequest文字列をパラメータとしてくっつけます

(キチントためすなら、さらに&RelayState=+ SAML SSO設定ページのRelay Stateを指定します)https://login.microsoftonline.com/cd91xxxxxxxxxxxx/saml2?SAMLRequest=jZFNS8NAEIbv%2F...snip...zz8g0%3DできたURLをブラウザで開くと、MicrosoftアカウントのSigninページが表示されて、正常にサインインできれば、AWSのコンソール画面へ遷移します

(Microsoftアカウントへログイン済みであれば、Signinページは表示されず、AWSのコンソール画面へ遷移します)エラー

- AADSTS750054: SAMLRequest or SAMLResponse must be present as query string parameters in HTTP request for SAML Redirect binding.

- GETパラメータに

SAMLRequest=<request>が指定されていません- AADSTS750056: SAML message was not properly base64-encoded.

- SAMLRequestパラメータの内容がbase64デコードできない内容になっています

- base64エンコードがうまくできていないか、URLエンコードが悪いかもしれません

- AADSTS7500529: The value '1......' is not a valid SAML ID. The ID must not begin with a number.

- AuthnRequestXML内のID値は英字から始まる必要があります。数字から始めてはいけません

- AADSTS700016: Application with identifier 'https://signin.aws.amazon.com/saml' was not found in the directory 'cd91xxxxxxxxxxxx'. This can happen if the application has not been installed by the administrator of the tenant or consented to by any user in the tenant. You may have sent your authentication request to the wrong tenant.

- AuthnRequestで指定したIssuerと一致する設定がありません。Azure SAML SSO設定の

Identifier (Entity ID)を確認しますリンク

下記ページを参照させていただき、助けられました。ありがとうございます

- 投稿日:2020-07-04T18:17:40+09:00

クラウド上のPython2系のスクリプトを3系に移行しアップデートする作業メモ

これは何

いまだに動いているPython2系のスクリプトを3系にアップデートするときの作業(事前準備含む)の備忘メモ前提

- pyenvを使用してPythonのバージョン管理を行っている

- Dockerやvirtualenv, Pipenvは未使用

概要

- 移行するPythonを決める

- ローカルで検証する

- 本番(stg)でバージョンを上げる

手順

- 以下で簡単に移行手順を示します

事前調査

現在の動作環境を確認

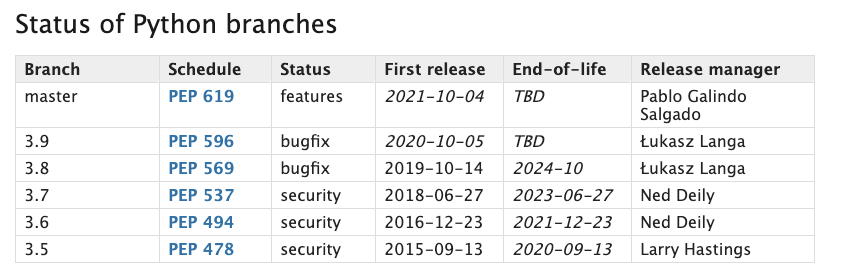

- 使用しているOSによってアップデートする先のPythonのバージョンが限られているので、事前に調査する

- サーバ上で

pyenv install --listして、移行できるPythonのバージョンを確認する- 以下はLinuxのOSが

Linux: Amazon Linux AMI release 2016.03だった場合の例[ec2-user@app]$ pyenv install --list Available versions: # 中略 3.6.0 3.6-dev 3.6.1 3.6.2 3.6.3 3.6.4 3.7.0b2 3.7-dev 3.8-dev # 後略移行先のPythonバージョンを決定

- 先ほどの

pyenv install --listでアップデートできるバージョンの中から、Pythonのバージョンを選定する

- パッチバージョンの数字の後に

devやb*が入っているものは、stableでないバージョンなので避ける- Python Developer’s Guideに各バージョンのメンテナンス期限などが書かれているので、EOLができる限り長いものを選ぶ

- 先ほどの

Linux: Amazon Linux AMI release 2016.03の例では、 上記の理由より3.6.4にするのが妥当

- Python Developer’s Guide: https://devguide.python.org/#status-of-python-branches

ローカルでの動作検証

Python3系で使用できないロジックの洗い出し

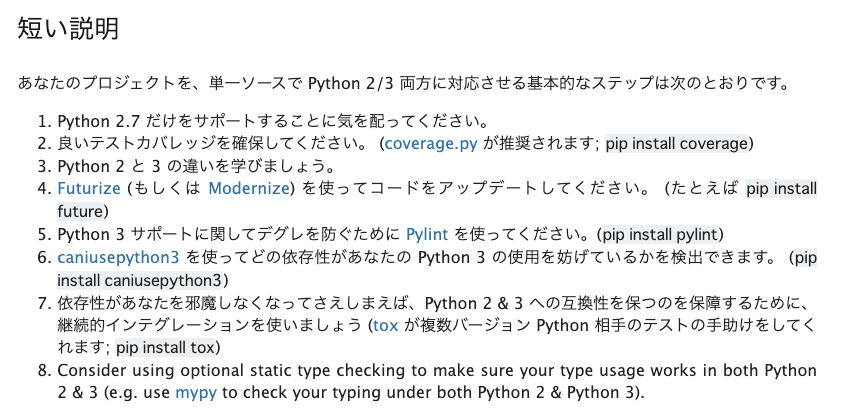

- futurizeでPythonのコードのアップデートを試みます

- applyされなかったファイルやメソッドをについて検証していきます

- Pythonの公式でも推奨されているやり方っぽいです

- Python 2 から Python 3 への移植: https://docs.python.org/ja/3/howto/pyporting.html#porting-python-2-code-to-python-3

- futurize Py2 to Py2/3: http://python-future.org/automatic_conversion.html#stage-1-safe-fixes

Python3系の記法に自動変換を行ってみる

- 2to3というライブラリで、Python2でのみ通用する記法を(ある程度)自動的に3系の記法に変換してくれます

- 3系への影響範囲が大きい場合は、こちらで一気に変換してみても良いかもしれません(過信は禁物、動作検証はすべき)

- これも、Python3の公式ドキュメントで記載されている方法論になります

- 2to3 Python 2 から 3 への自動コード変換: https://docs.python.org/ja/3/library/2to3.html#module-lib2to3

Pythonバージョンの切り替え&スクリプト実行

- 上記のライブラリでのコードやロジックの移行にある程度目処がついたら、実際にローカルで動かしていきます

- 主な順序は「

pyenvでバージョン切り替え」「ライブラリのインストール」「スクリプトの実行」となります- DBとの接続が必要な部分など、ローカルだけでは完結しないロジックがある場合はスキップするなど、実行可能な部分だけでも実行する

コケた場合のバックアップ方法をメモする

- ローカルで問題なく動作した場合、stgや本番環境のアップデートを行うことになります

- その前に、「仮にPython3のコードでの動作に問題があった場合」の切り戻しオペレーションをドキュメントか何かに記載しておきましょう

- 具体的に想定される切り戻し作業

pyenvで旧バージョンのPythonに切り替え- アップデートしたコードのcommitをrevertする

- 旧バージョンでライブラリをインストールし直す

移行実施

- 以降でいよいよ本番のスクリプトのPythonバージョンを変更していきます

- stg環境があればstg環境で先に実施する

Pythonバージョンの切り替え

pyenvでPythonのバージョンを切り替えていきます# 3.6.4をインストール $ pyenv install 3.6.4 $ pyenv versions system * 2.7 (set by /home/ec2-user/.pyenv/version) 3.6.4 # 追加されているはず $ pyenv local 3.6.4 $ pyenv rehash $ pyenv versions system 2.7 (set by /home/ec2-user/.pyenv/version) * 3.6.4 # 変更されているはず $ python --version Python 3.6.4 # 変更されているはずライブラリの再インストール

- Python3環境にライブラリをインストールします

- 以下は

requirements.txtを用いてインストールする例です$ pip install -r requirements.txt Collecting urllib3!=1.25.0,!=1.25.1,<1.26,>=1.21.1 (from requests->-r requirements.txt (line 5)) Cache entry deserialization failed, entry ignored Downloading https://files.pythonhosted.org/packages/e1/e5/df302e8017440f111c11cc41a6b432838672f5a70aa29227bf58149dc72f/urllib3-1.25.9-py2.py3-none-any.whl (126kB) 100% |████████████████████████████████| 133kB 9.1MB/s Collecting certifi>=2017.4.17 (from requests->-r requirements.txt (line 5)) Cache entry deserialization failed, entry ignored Cache entry deserialization failed, entry ignored Downloading https://files.pythonhosted.org/packages/57/2b/26e37a4b034800c960a00c4e1b3d9ca5d7014e983e6e729e33ea2f36426c/certifi-2020.4.5.1-py2.py3-none-any.whl (157kB) 100% |████████████████████████████████| 163kB 7.3MB/s # 以下略スクリプトの動作確認

- 手動で動かせるスクリプトの場合は、実際にスクリプトを動かしてみます

- エラーを吐かずに想定通り動作する場合は、移行成功です

- 一応動作ログを取得してファイルに吐き出すなり、ドキュメントに貼り付けておくなりしておくとベストです

[ec2-user@app]$ python main.py参考ドキュメント

- 投稿日:2020-07-04T18:06:41+09:00

AWS 認定デベロッパー – アソシエイト問題集

はじめに

- 本問題集は、私がAWS 認定デベロッパー – アソシエイトを受験するにあたって、無料の問題集が欲しいと思い作成しました。少しでも皆様のお役に立てれば幸いです。

- ソースはAWS公式サイトを前提としています。もし、間違いが有りましたらご指摘ください。

- 徐々に更新して問題数は増やしていこうと思っています。

問題

問1

以下に当てはまるものを選択肢から選択してください。

DynamoDBのSort Key以外に絞り込み検索を行うことが出来る。Partition Keyが同一で他のアイテムからの検索の為に使用できる。A. Local Secondary Index(LSI)

B. Global Secondary Index(GSI)問2

以下に当てはまるものを選択肢から選択してください。

DynamoDBの読み込みキャパシティーユニットの計算をしてください。項目サイズが3.5KB、1秒当たりの読込項目数が1000回/秒、強力な整合性のある読込をする場合の必要なキャパシティユニット。A. 1000RCU

B. 2000RCU

C. 3000RCU

D. 3500RCU問3

以下に当てはまるものを選択肢から選択してください。

DynamoDBの書き込みキャパシティーユニットの計算をしてください。項目サイズが1.1KB、1秒当たりの書込項目数が1000回/秒の場合の必要なキャパシティユニット。A. 1000WCU

B. 1100WCU

C. 2000RCU

D. 4400RCU問4

以下に当てはまるものを選択肢から選択してください。

DynamoDBのテーブル操作は公開APIを使用する事が出来ます。

「1件のアイテムを書き込むAPI」は何でしょうか?A. PutItem

B. UpdateItem

C. AddItem

D. WriteItem問5

以下に当てはまるものを選択肢から選択してください。

DynamoDBのテーブルからデータを読み取るには、GetItem、Query や Scan などのオペレーションを使用します。ですが、デフォルトではすべての項目属性を返します。すべての属性ではなく、一部の属性のみを取得するには、何を指定すれば良いでしょうか?A. S3 Select

B. DynamoDB Select

C. プロジェクション式

D. ラムダ式問6

以下に当てはまるものを選択肢から選択してください。

DynamoDBのテーブルの項目を自動的に削除する機能は何でしょうか?A. Automatic deletion

B. TTL

C. VACUUM

D. SQS問7

以下に当てはまるものを選択肢から選択してください。

Lambdaの関数がイベントの処理を終了すると、Lambda は呼び出しに関するメトリクスを Amazon CloudWatch に送信します。Lambdaの実行回数を計測したメトリックスを選択してください。A. Duration

B. Throttles

C. IteratorAge

D. Invocations問8

以下に当てはまるものを選択肢から選択してください。

Lambdaの関数呼び出しのパフォーマンスについてLambdaパフォーマンスメトリクスとして計測されます。イベントソースマッピングにおいてストリームの最後のデータを読み込んだ時刻からイベントをLambda関数に送信するまでの時間を計測したパフォーマンスメトリクスを選択してください。

(ストリームがレコードを受信した時刻 - イベントソースマッピングがイベントを関数に送信したときの時刻)A. Duration

B. DeadLetterErrors

C. IteratorAge

D. Invocations問9

以下に当てはまるものを選択肢から選択してください。

Lambda はイベントを処理するインスタンスの総数として同時実行メトリクスを報告しています。 プロビジョニングされた同時実行でイベントを処理している関数インスタンスの数を確認できる同時実行メトリクスを選択してください。A. ProvisionedConcurrentExecutions

B. ProvisionedConcurrencyUtilization

C. UnreservedConcurrentExecutions

D. ConcurrentExecutions問10

以下に当てはまるものを選択肢から選択してください。

Lambda の機能として、Lambda関数を異なるバージョンにデプロイ管理する事が出来る機能を選択してください。A. タグ

B. エイリアス

C. バージョン問11

以下に当てはまるものを選択肢から選択してください。

AWS Lambda では、関数の実行と保存に使用できるコンピューティングおよびストレージリソースの量が制限されています。制限の数を引き上げるには、サポートセンターコンソールにおいて上限緩和申請を行う必要が有ります。同時実行数のデフォルト制限数を以下から選択してください。A. 100

B. 1000

C. 10000問12

以下に当てはまるものを選択肢から選択してください。

Amazon DynamoDB と AWS Lambda はトリガー (DynamoDB ストリーム 内のイベントに自動的に応答するコード) を作成できます。トリガーを使用すると、DynamoDB テーブル内のデータ変更に対応するアプリケーションを構築できます。必要な設定方法を以下から選択してください。A. 特別な設定は要らない

B. DynamoDBテーブルのストリームを有効にする

C. DynamoDBテーブルのストリームを有効にした上で、AWS Lambda 関数のイベントソースマッピングを作成する。イベントソースマッピングの--event-sourceにDynamoDBのARNを指定する

C. DynamoDBテーブルのストリームを有効にした上で、DynamoDBのAttributesにAWS Lambda関数のARNを設定し、イベントソースマッピングを作成する。問13

以下に当てはまるものを選択肢から選択してください。

AWS Lambda 関数を使用して、Amazon Kinesis データストリームのレコードを処理できます。Lambda関数の呼び出しが増加したためにパフォーマンスが悪化しました。適切な対処方法を以下から1つ選択してください。A. Lambda関数の割り当てメモリを増やす

B. Lambda関数のエイリアスを使用する

C. Kinesis ストリームのシャード数を増やす

D. Kinesis ストリームの割り当てメモリを増やす問14

以下に当てはまるものを選択肢から選択してください。

Lambdaオーソライザーについて適切に述べているものを選択してください。A. Lambda関数を実行する際の認証機能

B. Lambda 関数を使用して、API へのアクセスを制御する API Gateway の機能

C. Lambda 関数の新しいバージョンを自動的にデプロイし、新しいバージョンへのトラフィックを徐々に増やしていくことが出来る機能

D. Amazon RDS Proxy データベースプロキシを作成できる機能問15

以下に当てはまるものを選択肢から選択してください。

Lambda環境変数を使用して、データベース接続情報などの情報を安全に保存する事が出来ます。また開発者は、コードを更新することなく関数の動作を制御出来ます。環境変数を保管時に暗号化しておきたいと思います。以下選択肢から適切なものを1つ選択してください。A. IAMロールをLambda関数に割り当てる

B. KMSを使用する

C. Lambda Secretを使用する問16

以下に当てはまるものを選択肢から選択してください。

Amazon S3やAmazon SNS などのサービスはLambda関数を非同期に呼び出してイベントを処理することが出来ます。関数を非同期的に呼び出す場合は、関数コードからのレスポンスを待機しません。

Lambda は関数の非同期イベントキューを管理し、エラー発生時に再試行を行います。関数からエラーが返された場合、Lambda はその関数をあと 2 回再試行します。

この場合、Lambda関数は合計何回実行されることになるでしょうか?A. 2回

B. 3回

C. 4回

D. 無限問17

以下に当てはまるものを選択肢から選択してください。

Amazon API Gateway は、CloudWatch にメトリクスデータを毎分送信します。

API Gateway がバックエンドにリクエストを中継してから、バックエンドからレスポンスを受け取るまでの時間を観測できるAPI Gateway メトリクスを1つ選択してください。A. IntegrationLatency

B. Latency

C. Backend Latency問18

以下に当てはまるものを選択肢から選択してください。

Lambda関数にデッドレターキューを設定することが出来ます。非同期呼び出しが失敗したイベントを送信できるトピックを選択してください。2つ選択します。A. Amazon Simple Queue Service (SQS)

B. Amazon Simple Notification Service(SNS)

C. Amazon Kinesis

D. Amazon Simple Storage Service (S3)問19

以下に当てはまるものを選択肢から選択してください。

Lambdaオーソライザーには2種類あります。以下選択肢から2つ選択してください。A. セッションベース

B. トークンベース

C. APIベース

D. リクエストパラメータベース問20

以下に当てはまるものを選択肢から選択してください。

CodeDeployのアプリケーション仕様ファイルでデプロイを管理するために CodeDeploy によって使用される YAML 形式または JSON 形式ファイルの名前。ここでは、Amazon ECS または AWS Lambda デプロイの AppSpec file の名前を指します。A. deployspec.yaml / deployspec.json

B. appspec.yaml / appspec.json

C. codespec.yaml / codespec.json

D. deploy.yaml / deploy.json問21

以下に当てはまるものを選択肢から選択してください。

AWS Lambda フックは、ライフサイクルイベントの名前の後の新しい行に文字列で指定された 1 つの Lambda 関数です。各フックはデプロイごとに 1 回実行されます。置き換えタスクセットが作成される前にタスクを実行するために使用するライフサイクルイベントを選択してください。A. BeforeAllowTraffic

B. BeforeInstall

C. AfterInstall

D. AfterAllowTestTraffic

E. AfterAllowTraffic問22

以下に当てはまるものを選択肢から選択してください。

EC2/オンプレミス のデプロイのフックは、デプロイごとに 1 回インスタンスに対して実行されます。フックには実行するスクリプトを 1 つまたは複数指定することができます。デプロイが正常に完了したことを確認するために使用するライフサイクルイベントを選択してください。A. DownloadBundle

B. ValidateService

C. BeforeBlockTraffic

D. AfterBlockTraffic

E. BeforeAllowTraffic問23

以下に当てはまるものを選択肢から選択してください。

CodePipeline パイプラインに手動の承認アクションを追加する方法を以下から選択してください。A. 出来ない

B. CodePipelineコンソールのアクション編集ページでアクションプロバイダーの承認を[手動承認]、SNSトピックのARNを指定する

C. CodeBuildコンソールのアクション編集ページでアクションプロバイダーの承認を[手動承認]、SNSトピックのARNを指定する

D. CodeDeployコンソールのアクション編集ページでアクションプロバイダーの承認を[手動承認]、SNSトピックのARNを指定する問24

以下に当てはまるものを選択肢から選択してください。

AWS CodeCommitのリポジトリ制限値について。アカウント毎にいくつまでか?A. 100

B. 1000

C. 10000

D. 上限はない問25

以下に当てはまるものを選択肢から選択してください。

CodeBuildのビルドアーティファクト (キャッシュ、ログ、出力された生のテストレポートファイルそしてビルド結果など) を保管している時の暗号化の設定方法として、記載が正しいものを選択してください。A. デフォルトで暗号化されています。Amazon S3 のカスタマーマスターキー (CMKs) が使用されています。

B. 署名バージョン 4 の署名プロセスで署名された TLS 接続を使用して保護する

C. 暗号化する事は出来ません。問26

以下に当てはまるものを選択肢から選択してください。

AWS CodeBuild でビルドを計画するにあたって、CodeBuildのビルド仕様に関して記載された仕様ファイルをソースコードに含めることにしました。適切なものを1つ選択してください。A. deployspec.ymlをソースディレクトリのルートに配置

B. codebuild.ymlをソースディレクトリのルートに配置

C. buildspec.yml をソースディレクトリのルートに配置問27

以下に当てはまるものを選択肢から選択してください。

AWS CodeBuildの環境変数のうち、ビルドが実行されている AWS リージョンを取得できるものを選択してください。A. BUILD_DEFAUT_REGION/BUILD_REGION

B. CODE_BUILD_DEFAULT_REGION/CODE_BUILD_REGION

C. DEPLOY_DEFAULT_REGION/DEPLOY_REGION

D. AWS_DEFAULT_REGION/AWS_REGION問28

以下に当てはまるものを選択肢から選択してください。

AWS CodeBuild 内でユーザーやロール、または AWS のサービスによって実行されたアクションを記録する事が出来るサービスを選択してください。A. S3

B. CloudWatch

C. Amazon S3 Glacier

D. AWS CloudTrail問29

以下に当てはまるものを選択肢から選択してください。

AWS Command Line Interface (AWS CLI)、または AWS SDK を使用して、AWS CodeBuild で使用するエンドポイントを指定する事が出来ます。

AWS CLI を使用して、AWS CodeBuild にアクセスするエンドポイントを指定するには、CodeBuild コマンドに 何の引数を指定すれば良いでしょうか?A. --endpoint-uri 引数

B. --endpoint-url 引数

C. --access-point-uri 引数

D. --access-point-url 引数問30

以下に当てはまるものを選択肢から選択してください。

AWS Elastic Beanstalkの拡張状態ヘルスレポートを有効にすることで、環境内のリソースに関する追加の情報を収集できます。Elastic Beanstalk は、収集された情報を分析して環境全体の状態をより的確に示し、アプリケーションの使用を妨げる可能性のある問題を特定する事が可能となります。

環境内で実行されている Amazon EC2 インスタンスに関する詳細なヘルス情報をするには、どのような設定を行えば良いでしょうか?A. EC2インスタンスのヘルス情報を収集する事は出来ない

B. SSM エージェントをEC2にインストール

C. ヘルスエージェントをEC2にインストール

D. CloudWatchエージェントをEC2にインストールする問31

以下に当てはまるものを選択肢から選択してください。

AWS Elastic Beanstalkのデプロイオプションについて、以下の特徴を示すものを選択してください。

低速のデプロイ方法で、かつ、デプロイ時に既存のインスタンスを更新するのではなく、常に新しいアプリケーションバージョンを新しいインスタンスにデプロイします。A. Rolling

B. Always new deploy

C. Rolling with additional batch

D. Immutable問32

以下に当てはまるものを選択肢から選択してください。

AWS Elastic Beanstalk アプリケーションで、完了するまでに長い時間がかかるオペレーションまたはワークフローを実行する場合、それらのタスクを専用のワーカー環境にオフロードできます。

ソースファイルに定期的なタスクを定義する必要が有ります。そのファイル名を選択してください。A. batch.yaml

B. cron.yaml

C. task.yaml

D. work.yaml問33

以下に当てはまるものを選択肢から選択してください。

Elastic Beanstalk コンソールまたは EB CLI を使用して新しいバージョンのアプリケーションをアップロードするたびに、Elastic Beanstalk はアプリケーションバージョンを作成します。使用しなくなったバージョンを削除しないと、最終的にはアプリケーションバージョンクォータに到達し、そのアプリケーションの新しいバージョンを作成できなくなります。

クォータに到達するのを回避する方法を選択してください。A. アプリケーションにアプリケーションバージョンクォータ削除ポリシーを適用する

B. アプリケーションにアプリケーションバージョンライフサイクルポリシーを適用する

C. アプリケーションにアプリケーションバージョンデプロイポリシーを適用する

D. アプリケーションにアプリケーションバージョンスケジュール設定を行う問34

以下に当てはまるものを選択肢から選択してください。

環境を作成するときに使用する、環境の名前、ソリューションスタックと環境リンクを設定するために、YAML 形式の環境マニフェストをアプリケーションソースバンドルのルートに含めることができます。

含めるファイルを以下から選択してください。A. cron.yaml

B. appspec.yaml

C. conf.yaml

D. env.yaml問35

以下に当てはまるものを選択肢から選択してください。

AWS SAM は、AWS でサーバーレスアプリケーションを構築するために使用することができるオープンソースフレームワークです。AWS SAM を使用してサーバーレスアプリケーションを定義するにはCloud Formationテンプレートにおいて AWS SAMテンプレート仕様を使用する必要が有ります。

必要な定義を以下選択肢から選択してください。A. Transform: AWS::Serverless-2016-10-31

B. Serverless: AWS::Transform-2016-10-31

C. Type: AWS::Serverless-2016-10-31

D.Runtime: AWS::Serverless-2016-10-31問36

以下に当てはまるものを選択肢から選択してください。

AWS CloudFormation には、スタックの管理に役立ついくつかの組み込み関数が用意されています。実行するまでわからない値をプロパティに代入するには、テンプレートで組み込み関数を使用できます。

テンプレートのリソースから属性の値を返す組み込み関数を以下から選択してください。A. Fn::FindInAZs

B. Fn::GetAZs

C. Fn::GetAtt

D. Fn::FindInMap問37

以下に当てはまるものを選択肢から選択してください。

AWS CloudFormation を使用する際、関連リソースを単一のユニットとして管理でき、これを作成、更新、削除することで、リソースのコレクションを作成、更新、削除することが出来ます。A. テンプレート

B. コレクションセット

C. スタック

D. 変更セット問38

以下に当てはまるものを選択肢から選択してください。

AWS CloudFormation の組み込み関数について

指定されたリージョンのアベイラビリティーゾーンを含んだ配列を返す組み込み関数を以下から選択してください。A. Fn::FindInAZs

B. Fn::GetAZs

C. Fn::GetAtt

D. Fn::FindInMap問39

以下に当てはまるものを選択肢から選択してください。

AWS CloudFormation のスタックで実行中のリソースに変更を加える場合、スタックを更新する必要が有りますが、実際にリソースに変更を加える前に変更点を確認する事が出来ます。A. テンプレート

B. 変更セット

C. CodeCommit

D. CodePipeline問40

以下に当てはまるものを選択肢から選択してください。

AWS CloudFormation のスタックを削除することでスタックとスタック内のすべてのリソースを削除出来ます。

スタックの削除時に、必要なスタック内のリソースを保持するには何を設定すれば良いでしょうか?A. リソースポリシー

B. IAMポリシー

C. 削除ポリシー

D. appspec.yml問41

以下に当てはまるものを選択肢から選択してください。

AWS CloudFormation において AWS 認証情報のない一時的なアクセス権をユーザーに付与する必要があります。一時的なアクセス権を付与する場合は、何を設定すれば良いでしょうか?A. IAMユーザー

B. IAMポリシー

C. IAMロール

D. AWS Security Token Service (AWS STS)問42

以下に当てはまるものを選択肢から選択してください。

AWS X-Ray はアプリケーションが処理するリクエストに関するデータを収集するサービスです。データを表示、フィルタリング、洞察を取得して問題の識別や最適化の機会を識別するために使用するツールを提供しています。インターセプター(HTTPリクエストのトレース)、クライアントハンドラー(AWS SDKクライアントの計測)、HTTPクライアントの計測が可能です。

X-Rayの概念でホスト、リクエスト、レスポンス、行った作業(開始・終了時刻、サブセグメント)、発生した問題(エラー、障害、例外)のデータを記録しているものを1つ選択してください。A. サンプリング

B. セグメント

C. サブセグメント問43

以下に当てはまるものを選択肢から選択してください。

DynamoDBの様なセグメントを送信しないサービスでは、X-Ray SDK はトレースの情報を何をもって表示するでしょうか?A. サンプリング

B. セグメント

C. サブセグメント問44

以下に当てはまるものを選択肢から選択してください。

X-Rayにおいて効率的にトレースを行ってアプリケーションが処理するリクエストの代表的なサンプルを提供するため、X-Ray SDK によってサンプリングアルゴリズムが適用され、トレースするリクエストが決定されます。デフォルトでは、X-Ray SDK は 1 秒ごとに最初のリクエスト(リザーバサイズ)と、追加リクエストの 5%(固定レート) を記録します。以下設定の場合の、トレース可能なリクエスト数を計算してください。

リザーバサイズ:30

固定レート:50%A. 80

B. 45

C. 130

D. 150問45

以下に当てはまるものを選択肢から選択してください。

X-Rayにおいてサンプリングされている場合でも、複雑なアプリケーションでは大量のデータが生成されます。AWS X-Ray コンソールでは、操作が簡単なサービスグラフのビューを提供します。特定の条件を指定してトレースを検索することが出来るものを選択してください。A. ラムダ式

B. トレース式

C. フィルタ式

D. リクエストビュー問46

以下に当てはまるものを選択肢から選択してください。

AWS X-Ray デーモンを実行するにポートをリッスンする必要が有ります。デフォルトポートについて、以下から選択してください。A. TCPポート2000

B. UDPポート2000

C. HTTPポート80

D. HTTPSポート8080問47

以下に当てはまるものを選択肢から選択してください。

ECSクラスターは、タスクまたはサービスの論理グループです。 EC2 を使用してタスクまたはサービスを実行している場合、クラスターはコンテナインスタンスのグループ化でもあります。A. All Deployment

B. Blue-Green Deployment

C. Application Deployment

D. Traffic Deployment問48

以下に当てはまるものを選択肢から選択してください。

AWS OpsWorks スタックには、一連のスタックコマンドが用意されており、このスタックコマンドを使用して、スタックのインスタンスに対してさまざまな操作を実行できます。スタック コマンドを実行するには、[Stack] ページで、[Run Command] をクリックします。インスタンスに対して指定された一連のレシピを実行するスタックコマンドを以下から選択してください。A. Run Commands

B. Execute Recipes

C. All At Once Commands

D. Run Recipes問49

AWS OpsWorksのすべてのインスタンスには、サービスと定期的に通信する AWS OpsWorks スタックエージェントがあります。AWS OpsWorks スタックでは、インスタンスの状態のモニタリングにこの通信が使用されます。エージェントとサービスとの通信が約 5 分以上途絶えると、AWS OpsWorks スタックではインスタンスが失敗したと見なすにはどのような設定を行えばよいでしょうか?

A. 出来ない

B. AWSサポートコンソールから依頼する

C. Auto healing enabledを有効にする

D. Auto Recovely を有効にする問50

AWS OpsWorks スタックは、Chef クックブックを使用して、パッケージのインストールや設定、アプリケーションのデプロイなどのタスクを処理します。カスタムクックブックはオンラインリポジトリ (.zip ファイルのようなアーカイブまたは Git のような ソース管理マネージャー) に保存する必要があります。

各クックブックディレクトリには、標準ディレクトリとファイルが少なくとも 1 つ (通常はすべて)、標準の名前で含まれていますが、クックブックの属性を記したファイルを以下から選択してください。A. recipes

B. attributes

C. configs

D. cookbooks正解

問1の正解

A. Local Secondary Index(LSI)

- DynamoDBにおいては、Partition Key とSort Keyを併せて絞り込み検索を行うことが出来ます。Sort Key以外で絞込検索を行いたいときに、Local Secondary Index(LSI)を使用します。

- Global Secondary Index(GSI)はLSIと異なり、Partition Key属性の代わりに検索を行う為のIndexです。

- よって正解は、AのLocal Secondary Index(LSI)となります。

ベーステーブルのプライマリキーを使用してデータのクエリを実行する必要があるのは、一部のアプリケーションだけです。ただし、代替のソートキーが役に立つ場合があります。アプリケーションにソートキーという選択肢を提供するために、Amazon DynamoDB テーブルに 1 つ以上のローカルセカンダリインデックスを作成して、それらのインデックスに対して Query または Scan リクエストを実行できます。

https://docs.aws.amazon.com/ja_jp/amazondynamodb/latest/developerguide/LSI.html問2の正解

A. 1000RCU

DynamoDBの読込キャパシティユニットの計算式は以下です。

1秒辺りの読込項目数 × 項目のサイズ(4KBブロック)

※「整合性のある読込(≠強い整合性のある読込)」の場合は 上記に 1/2 を掛ける。

※項目のサイズは4KBブロックで有る。よって、3.5KBの場合は4KBとみなす。要は、4KBの入れ物の中に納まったら、4KBとみなす。4.1KBの様に4KBの入れ物に納まらなかったら、4KBのブロックを2つ消費する考え今回の例だと、

1秒辺りの読込項目数=1000

項目のサイズ=3.5KB

なので

1000 × 1 = 1000RCUとなります。1 つの読み込みキャパシティーユニットは、最大サイズ 4 KB の項目について、1 秒あたり 1 回の強力な整合性のある読み込み、あるいは 1 秒あたり 2 回の結果整合性のある読み込みを表します。

例えば、10 ユニットのプロビジョニングされた読み取りキャパシティーでテーブルを作成するとします。これにより、最大 4 KB の項目について、1 秒あたり 10 回の強い整合性のある読み込み、または 20 回の結果的に整合性のある読み込みを行えます。

4 KB を超える項目の読み込みには、より多くの読み取りキャパシティーユニットを消費します。たとえば、8 KB (4 KB × 2) の項目の強い整合性のある読み込みは、2 ユニットの読み込みキャパシティーユニットを消費します。同じ項目の結果的に整合性のある読み込みは、読み込みキャパシティーを 1 ユニットしか消費しません。

読み込みの項目サイズは、次の 4 KB の倍数に切り上げられます。たとえば、3,500 バイトの項目の読み込みは、4 KB の項目の読み取りと同じスループットを消費します。

https://docs.aws.amazon.com/ja_jp/amazondynamodb/latest/developerguide/ProvisionedThroughput.html#ProvisionedThroughput.CapacityUnits.Read問3の正解

C. 2000WCU

DynamoDBの書込キャパシティユニットの計算式は以下です。

1秒辺りの書込項目数 × 項目のサイズ(1KBブロック)

今回の例だと、

1秒辺りの読込項目数=1000

項目のサイズ=1.1KB

なので1KBブロックが2つ必要となります。

よって、

1000 × 2 = 2000RCUとなります。1 つの書き込みキャパシティーユニットは、最大サイズが 1 KB の項目について、1 秒あたり 1 回の書き込みを表します。

例えば、10 ユニットのプロビジョニングされた書き込みキャパシティーでテーブルを作成するとします。これにより、1 秒あたり最大でサイズが 1 KB の項目について、1 秒あたり 10 回の書き込みを行えます。

書き込みの項目サイズは、次の 1 KB の倍数に切り上げられます。たとえば、500 バイトの項目の書き込みは、1 KB の項目の書き込みと同じスループットを消費します。

https://docs.aws.amazon.com/ja_jp/amazondynamodb/latest/developerguide/ProvisionedThroughput.html#ProvisionedThroughput.CapacityUnits.Write問4の正解

A. PutItem

「B. UpdateItem」は更新を掛けるAPIですので、違います。

「C. AddItem」、「D. WriteItem」というAPIは有りませんので、違います。DynamoDBの主なAPIをまとめました。

API 説明 PutItem 項目を作成します。 GetItem 項目を読み取ります。 UpdateItem 項目を更新します。 DeleteItem 項目を削除します。 BatchGetItem 1 つ以上のテーブルから最大 100 個の項目を読み取ります。 BatchWriteItem 1 つ以上のテーブルから最大 25 個の項目を作成または削除します。 DynamoDB は、作成、読み込み、更新、削除 (CRUD) の 4 つの基本的なオペレーション機能を提供します。

PutItem — 項目を作成します。

GetItem — 項目を読み取ります。

UpdateItem — 項目を更新します。

DeleteItem — 項目を削除します。

これらの各オペレーションでは、作業対象の項目のプライマリキーを指定する必要があります。たとえば、GetItem を使用して項目を読み込むには、その項目のパーティションキーとソートキー (該当する場合) を指定する必要があります。

4 つの基本的な CRUD オペレーションに加えて、DynamoDB は以下も提供します。

BatchGetItem — 1 つ以上のテーブルから最大 100 個の項目を読み取ります。

BatchWriteItem — 1 つ以上のテーブルから最大 25 個の項目を作成または削除します。

これらのバッチ操作は、複数の CRUD オペレーションを単一のリクエストにまとめます。さらに、応答のレイテンシーを最小限に抑えるため、バッチオペレーションは項目を並列で読み書きします。

https://docs.aws.amazon.com/ja_jp/amazondynamodb/latest/developerguide/WorkingWithItems.html問5の正解

C. プロジェクション式

プロジェクション式を使用する事で1つ以上の属性を指定して、取得する事が出来ます。

例:プロジェクション式を使用する場合(CLIの例)

aws dynamodb get-item \ --table-name ProductCatalog \ --key file://key.json \ --projection-expression "Description, RelatedItems[0], ProductReviews.FiveStar"上記例の通り、

--projection-expressionを指定します。問6の正解

B. TTL

設定方法は、TTL属性にしたい属性を設定し、有効にするだけです。

該当の属性内の値は時間をエポック形式で含む数値データ型とします。Amazon DynamoDB Time to Live (TTL) では、項目ごとのタイムスタンプを定義して、項目が不要になる時期を特定できます。指定されたタイムスタンプの日付と時刻の直後に、DynamoDB は書き込みスループットを消費することなく、テーブルから項目を削除します。TTL は、ワークロードのニーズに合わせて最新の状態に保たれている項目のみを保持することで、保存されたデータボリュームを削減する手段として、追加料金なしで提供されます。

https://docs.aws.amazon.com/ja_jp/amazondynamodb/latest/developerguide/TTL.html問7の正解

D. Invocations

Lambdaの呼び出しメトリスの主なものを以下にまとめました。

メトリクス 説明 Invocations 関数コードが実行された回数を記録します。 Errors 関数エラーが発生した呼び出しの数。 DeadLetterErrors 非同期呼び出しの場合、Lambda がイベントをデッドレターキューに送信しようとしたが、失敗した回数。 DestinationDeliveryFailures 非同期呼び出しの場合、Lambda がイベントを送信先に送信しようとしたが、失敗した回数。 Throttles スロットリングされた呼び出しリクエストの数。AWSアカウント単位でLambdaの同時期同数超過が発生した回数 ProvisionedConcurrencyInvocations プロビジョニングされた同時実行で関数コードが実行される回数。 問8の正解

C. IteratorAge

Lambdaのパフォーマンスメトリスの主なものを以下にまとめました。

メトリクス 説明 Duration 関数コードがイベントの処理に費やす時間。 IteratorAge ストリームから読み取るイベントソースマッピングの場合、イベントの最後のレコードの所要時間。 問9の正解

A. ProvisionedConcurrentExecutions

Lambdaの同時実行メトリクスを以下にまとめました。

メトリクス 説明 ConcurrentExecutions イベントを処理している関数インスタンスの数。 ProvisionedConcurrentExecutions プロビジョニングされた同時実行でイベントを処理している関数インスタンスの数。 ConcurrentExecutions イベントを処理している関数インスタンスの数。 ProvisionedConcurrencyUtilization Lambdaのバージョン、エイリアス機能を使用した場合、ProvisionedConcurrentExecutions の値を、割り当て済みのプロビジョニングされた同時実行の合計量で割った値。 UnreservedConcurrentExecutions リージョン内の同時実行が予約されていない場合に、Lambda関数が同時実行処理されているイベントの数。 問10の正解

C. バージョン

バージョンを使用して、AWS Lambda 関数のデプロイを管理できます。たとえば、安定した実稼働バージョンのユーザーに影響を与えることなく、ベータテスト用の新しいバージョンの関数を公開できます。

https://docs.aws.amazon.com/ja_jp/lambda/latest/dg/configuration-versions.html問11の正解

B. 1000

ちなみに、同時実行数は「呼び出されたイベントの数/秒 x 平均実行時間」で求められます。

https://docs.aws.amazon.com/ja_jp/lambda/latest/dg/gettingstarted-limits.html

問12の正解

C. DynamoDBテーブルのストリームを有効にした上で、AWS Lambda 関数のイベントソースマッピングを作成する。イベントソースマッピングの

--event-sourceにDynamoDBのARNを指定するAmazon DynamoDB は AWS Lambda と統合されているため、トリガー (DynamoDB ストリーム 内のイベントに自動的に応答するコード) を作成できます。トリガーを使用すると、DynamoDB テーブル内のデータ変更に対応するアプリケーションを構築できます。

テーブルで DynamoDB ストリーム を有効にした場合、書き込む AWS Lambda 関数にストリームの Amazon リソースネーム (ARN) を関連付けることができます。テーブルの項目が変更されるとすぐに、新しいレコードがテーブルのストリームに表示されます。AWS Lambda はストリームをポーリングし、新しいストリームレコードを検出すると、Lambda 関数を同期的に呼び出します。

https://docs.aws.amazon.com/ja_jp/amazondynamodb/latest/developerguide/Streams.Lambda.htmlAWS CLI を使用して、AWS Lambda でイベントソースを追加する事が出来ます。

$ aws lambda create-event-source-mapping --function-name ProcessDynamoDBRecords \ --batch-size 100 --starting-position LATEST --event-source DynamoDB-stream-arn問13の正解

C. Kinesis ストリームのシャード数を増やす

Lambda関数の呼び出しが増加したためにパフォーマンスが悪化したという条件ですので、スループット向上の為、Kinesisストリームのシャード数を増やすことが有効と思われます。

Lambda関数自体の処理性能が悪い場合は、「A. Lambda関数の割り当てメモリを増やす」が有効です。

「B. Lambda関数のエイリアスを使用する」はパフォーマンスには無関係です。「D. Kinesis ストリームの割り当てメモリを増やす」はでたらめです。シャードを追加して Kinesis ストリーム処理のスループットを向上させます。 Kinesis ストリームは 1 つ以上のシャードで構成されます。 Lambda は、最大で 1 つの同時呼び出しを使用して各シャードをポーリングします。たとえば、ストリームに 100 個のアクティブなシャードがある場合は、最大で 100 個の Lambda 関数呼び出しが同時に実行されます。シャードの数を増やすと、直接的な結果として、Lambda 関数の同時呼び出しの最大数が増えます。また、Kinesis ストリーム処理のスループットが増える場合があります。Kinesis ストリームのシャード数を増やす場合は、データの適切なパーティションキー (パーティションキーを参照) を選択していることを確認し、関連レコードが同じシャードに割り当てられ、データが適切に配分されるようにします。

https://docs.aws.amazon.com/ja_jp/lambda/latest/dg/best-practices.html#stream-events問14の正解

B. Lambda 関数を使用して、API へのアクセスを制御する API Gateway の機能

「A. Lambda関数を実行する際の認証機能」はIAM機能です。「C. Lambda 関数の新しいバージョンを自動的にデプロイし、新しいバージョンへのトラフィックを徐々に増やしていくことが出来る機能」はLambda 関数のローリングデプロイの機能についてです。「D. Amazon RDS Proxy データベースプロキシを作成できる機能」はLambdaコンソールを使用して作成できるデータベースプロキシの事です。

Lambda オーソライザー (以前のカスタムオーソライザー) は、Lambda 関数を使用して API へのアクセスを制御する API Gateway の機能です。

Lambda オーソライザーは、OAuth や SAML などのベアラートークン認可戦略を使用する、または発信者 ID を判断するためにリクエストパラメータを使用するカスタム認証スキームを実装する場合に便利です。

クライアントが API のメソッドの 1 つにリクエストを送信すると、API Gateway は Lambda オーソライザーを呼び出します。これは発信者 ID を入力として受け取り、IAM ポリシーを出力として返します。

Lambda オーソライザーには 2 種類あります。

トークンベース の Lambda オーソライザー (TOKEN オーソライザーとも呼ばれる) は、JSON ウェブトークン (JWT) や OAuth トークンなどのベアラートークンで発信者 ID を受け取ります。

リクエストパラメータベースの Lambda オーソライザー (REQUEST オーソライザーとも呼ばれる) は、ヘッダー、クエリ文字列パラメータ、stageVariables、および $context 変数の組み合わせで、発信者 ID を受け取ります。

https://docs.aws.amazon.com/ja_jp/apigateway/latest/developerguide/apigateway-use-lambda-authorizer.html問15の正解

B. KMSを使用する

Lambda は、環境変数を保管時に暗号化して安全に保存します。別の暗号化キーを使用したり、クライアント側で環境変数値を暗号化したり、AWS Secrets Manager で AWS CloudFormation テンプレートを使用して環境変数を設定したりするように Lambda を設定できます。

https://docs.aws.amazon.com/ja_jp/lambda/latest/dg/configuration-envvars.html問16の正解

B. 3回

1回実行された後、2回再試行されるので、合計3回となります。

問17の正解

A. IntegrationLatency

API Gateway メトリクスを以下まとめました。

メトリクス 説明 4XXError 指定された期間に取得されたクライアント側エラーの数。 5XXError 指定された期間に取得されたサーバー側エラーの数。 CacheHitCount 指定された期間内に API キャッシュから配信されたリクエストの数。 CacheMissCount API キャッシュが有効になっている特定の期間における、バックエンドから提供されたリクエストの数。 Count 指定された期間内の API リクエストの合計数。 IntegrationLatency API Gateway がバックエンドにリクエストを中継してから、バックエンドからレスポンスを受け取るまでの時間。 Latency API Gateway がクライアントからリクエストを受け取ってから、クライアントにレスポンスを返すまでの時間。 問18の正解

A. Amazon Simple Queue Service (SQS)

B. Amazon Simple Notification Service(SNS)https://docs.aws.amazon.com/ja_jp/lambda/latest/dg/invocation-async.html#dlq

問19の正解

B. トークンベース

D. リクエストパラメータベースLambda オーソライザーには 2 種類あります。

トークンベース の Lambda オーソライザー (TOKEN オーソライザーとも呼ばれる) は、JSON ウェブトークン (JWT) や OAuth トークンなどのベアラートークンで発信者 ID を受け取ります。

リクエストパラメータベースの Lambda オーソライザー (REQUEST オーソライザーとも呼ばれる) は、ヘッダー、クエリ文字列パラメータ、stageVariables、および $context 変数の組み合わせで、発信者 ID を受け取ります。

https://docs.aws.amazon.com/ja_jp/apigateway/latest/developerguide/apigateway-use-lambda-authorizer.html問20の正解

B. appspec.yaml / appspec.json

EC2/オンプレミス デプロイの AppSpec file の名前は appspec.yml または appspec.json にする必要があります。Amazon ECS または AWS Lambda デプロイの AppSpec file の名前は appspec.yaml または appspec.json にする必要があります。

https://docs.aws.amazon.com/ja_jp/codedeploy/latest/userguide/reference-appspec-file.html問21の正解

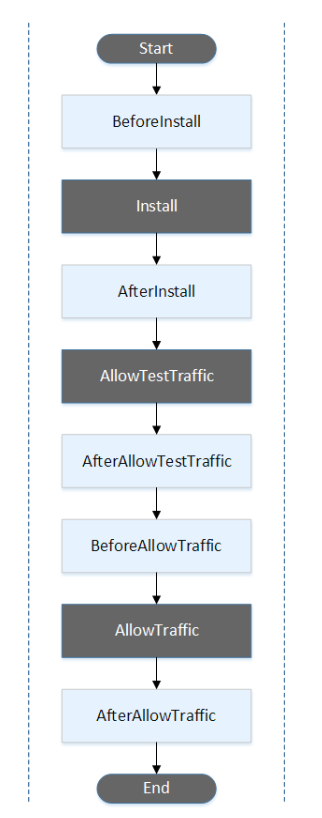

B. BeforeInstall

BeforeInstall – 置き換えタスクセットが作成される前にタスクを実行するために使用します。1 つのターゲットグループが元のタスクセットに関連付けられています。オプションのテストリスナーが指定されている場合、それは元のタスクセットに関連付けられます。この時点で、ロールバックはできません。

AfterInstall – 置き換えタスクセットが作成され、ターゲットグループの 1 つがそれに関連付けられた後、タスクを実行するために使用します。オプションのテストリスナーが指定されている場合、それは元のタスクセットに関連付けられます。このライフサイクルイベントでのフック関数の結果により、ロールバックをトリガーできます。

AfterAllowTestTraffic – テストリスナーが置き換えタスクセットにトラフィックを提供した後、タスクを実行するために使用します。この時点でのフック関数の結果により、ロールバックをトリガーできます。

BeforeAllowTraffic – 2 番目のターゲットグループが置き換えタスクセットに関連付けられた後、かつ、トラフィックが置き換えタスクセットに移行される前に、タスクを実行するために使用します。このライフサイクルイベントでのフック関数の結果により、ロールバックをトリガーできます。

AfterAllowTraffic – 2 番目のターゲットグループが置き換えタスクセットにトラフィックを提供した後、タスクを実行するために使用します。このライフサイクルイベントでのフック関数の結果により、ロールバックをトリガーできます。

Amazon ECS デプロイでのフックの実行順

問22の正解

B. ValidateService

ApplicationStop – このデプロイライフサイクルイベントは、アプリケーションリビジョンがダウンロードされる前でも発生します。アプリケーションを適切に中止するか、現在インストールされているパッケージを削除してデプロイの準備をする場合は、このイベントのスクリプトを指定できます。このデプロイライフサイクルイベントに使用される AppSpec file とスクリプトは、前回正常にデプロイされたアプリケーションリビジョンのものです。

DownloadBundle – このデプロイライフサイクルイベント中に、CodeDeploy エージェントはアプリケーションリビジョンファイルを一時的な場所にコピーします。

Amazon Linux、Ubuntu Server、および RHEL Amazon EC2 インスタンスの /opt/codedeploy-agent/deployment-root/deployment-group-id/deployment-id/deployment-archive フォルダ。

Windows Server Amazon EC2 インスタンスの C:\ProgramData\Amazon\CodeDeploy\deployment-group-id\deployment-id\deployment-archive フォルダ。

このイベントは CodeDeploy 用に予約されていて、スクリプトを実行するために使用することはできません。

DownloadBundle デプロイライフサイクルイベント中に失敗するデプロイをトラブルシューティングするには、「「不明なエラー: 読み取り用に開いていません」で失敗した DownloadBundle デプロイライフサイクルイベントのトラブルシューティング」を参照してください。BeforeInstall – このデプロイライフサイクルイベントは、ファイルの復号や現在のバージョンのバックアップの作成などの事前インストールタスクに使用できます。

Install – このデプロイのライフサイクルイベントでは、CodeDeploy エージェントが一時的なロケーションからリビジョンファイルを最終的な送信先フォルダにコピーします。このイベントは CodeDeploy 用に予約されていて、スクリプトを実行するために使用することはできません。

AfterInstall – アプリケーションの設定や、ファイルのアクセス許可の変更などのタスクに、このデプロイライフサイクルイベントを使用できます。

ApplicationStart – 通常、このデプロイライフサイクルイベントを使用して、ApplicationStop 中に停止されたサービスを再起動します。

ValidateService – これが最後のデプロイライフサイクルイベントです。デプロイが正常に完了したことを確認するために使用されます。

BeforeBlockTraffic – このデプロイライフサイクルイベントを使用して、ロードバランサーから登録解除される前のインスタンスでタスクを実行できます。

BeforeBlockTrafficデプロイライフサイクルイベント中に失敗するデプロイをトラブルシューティングするには、「失敗した ApplicationStop、BeforeBlockTraffic、および AfterBlockTraffic デプロイライフサイクルイベントのトラブルシューティング」を参照してください。BlockTraffic – このデプロイライフサイクルイベント中は、現在トラフィックの処理中であるインスタンスに対するインターネットトラフィックのアクセスがブロックされます。このイベントは CodeDeploy 用に予約されていて、スクリプトを実行するために使用することはできません。

AfterBlockTraffic – このデプロイライフサイクルイベントを使用して、ロードバランサーから登録解除された後のインスタンスでタスクを実行できます。

AfterBlockTraffic デプロイライフサイクルイベント中に失敗するデプロイをトラブルシューティングするには、「失敗した ApplicationStop、BeforeBlockTraffic、および AfterBlockTraffic デプロイライフサイクルイベントのトラブルシューティング」を参照してください。BeforeAllowTraffic – このデプロイライフサイクルイベントを使用して、ロードバランサーに登録される前のインスタンスでタスクを実行できます。

AllowTraffic – このデプロイライフサイクルイベント中は、デプロイ後のインスタンスに対するインターネットトラフィックのアクセスが許可されます。このイベントは CodeDeploy 用に予約されていて、スクリプトを実行するために使用することはできません。

AfterAllowTraffic – このデプロイライフサイクルイベントを使用して、ロードバランサーに登録された後のインスタンスでタスクを実行できます。

問23の正解

B. CodePipelineコンソールのアクション編集ページでアクションプロバイダーの承認を[手動承認]、SNSトピックのARNを指定する

問24の正解

B. 1000

AWS アカウントあたり最大 1,000 件。この制限は変更が可能です。

https://docs.aws.amazon.com/ja_jp/codecommit/latest/userguide/limits.html問25の正解

A. デフォルトで暗号化されています。Amazon S3 のカスタマーマスターキー (CMKs) が使用されています。

保管時のデータの暗号化 - ビルドアーティファクト (キャッシュ、ログ、出力された生のテストレポートファイルそしてビルド結果など) は、デフォルトで暗号化されます。この暗号化には、AWS Key Management Service が管理する Amazon S3 のカスタマーマスターキー (CMKs) が使用されます。これらの CMK を使用しない場合は、カスタマー管理 CMK を独自に作成して設定する必要があります。

ビルド出力アーティファクトを暗号化するために CodeBuild で使用する AWS KMS キーの識別子は、 CODEBUILD_KMS_KEY_ID 環境変数に保存できます。

ビルドプロジェクトの作成時にカスタマー管理 CMK を指定できます。

https://docs.aws.amazon.com/ja_jp/codebuild/latest/userguide/security-encryption.html

問26の正解

C. buildspec.yml をソースディレクトリのルートに配置

buildspec をソースコードの一部として含める場合、デフォルトの buildspec ファイルの名前は buildspec.yml で、ソースディレクトリのルートに配置する必要があります。

https://docs.aws.amazon.com/ja_jp/codebuild/latest/userguide/build-spec-ref.html#build-spec-ref-name-storage問27の正解

D. AWS_DEFAULT_REGION/AWS_REGION

AWS CodeBuild の環境変数を以下まとめました。

CodeBuildの環境変数 説明 AWS_DEFAULT_REGION ビルドが実行されている AWS リージョン (例 AWS_REGION ビルドが実行されている AWS リージョン (例 CODEBUILD_BUILD_ARN ビルドの Amazon リソースネーム (ARN) (例 CODEBUILD_BUILD_ID ビルドの CodeBuild ID (例 CODEBUILD_BUILD_IMAGE CodeBuild ビルドイメージ識別子 (例 CODEBUILD_BUILD_NUMBER プロジェクトの現在のビルド番号。 CODEBUILD_BUILD_SUCCEEDING 現在のビルドが成功かどうか。ビルドが失敗の場合は 0 に設定され、成功の場合は 1 に設定されます。 CODEBUILD_INITIATOR ビルドを開始したエンティティ。CodePipeline でビルドが開始された場合は、パイプラインの名前を表します (例 CODEBUILD_KMS_KEY_ID CodeBuild がビルド出力アーティファクトを暗号化するために使用している AWS KMS キーの識別子 (例 CODEBUILD_LOG_PATH CloudWatch Logs でのビルドのログストリーム名。 CODEBUILD_RESOLVED_SOURCE_VERSION ビルドのソースコードのバージョンの識別子。その形式は、ソースコードリポジトリによって異なります。 CODEBUILD_SOURCE_REPO_URL 入力アーティファクトまたはソースコードリポジトリの URL。Amazon S3 では、これは s3 CODEBUILD_SOURCE_VERSION Amazon S3 では、入力アーティファクトに関連付けられたバージョン ID。CodeCommit では、ビルドするソースコードのバージョンに関連付けられたコミット ID またはブランチ名。GitHub、GitHub Enterprise Server、Bitbucket の場合、ビルドするソースコードのバージョンに関連付けられたコミット ID、ブランチ名、またはタグ名を指します。 CODEBUILD_SRC_DIR CodeBuild がビルドに使用するディレクトリパス CODEBUILD_START_TIME Unix タイムスタンプとして指定されたビルドの開始時間 (ミリ秒単位)。 CODEBUILD_WEBHOOK_ACTOR_ACCOUNT_ID Webhook イベントをトリガーしたユーザーのアカウント ID。 CODEBUILD_WEBHOOK_BASE_REF 現在のビルドをトリガーする Webhook イベントの基本参照名。プルリクエストでは、ブランチ参照を表します。 CODEBUILD_WEBHOOK_EVENT 現在のビルドをトリガーした Webhook イベント。 CODEBUILD_WEBHOOK_PREV_COMMIT 現在のビルドをトリガーする Webhook プッシュイベントの前の最新のコミットの ID。 CODEBUILD_WEBHOOK_HEAD_REF 現在のビルドをトリガーする Webhook イベントのヘッド参照名。ブランチ参照またはタグ参照を表します。 CODEBUILD_WEBHOOK_TRIGGER ビルドをトリガーした Webhook イベントを表示します。 HOME この環境変数は常に /root に設定されます。 https://docs.aws.amazon.com/ja_jp/codebuild/latest/userguide/build-env-ref-env-vars.html

問28の正解

D. AWS CloudTrail

AWS CodeBuild は AWS CloudTrail と統合されています。

このサービスは、CodeBuild 内でユーザーやロール、または AWS のサービスによって実行されたアクションを記録するサービスです。

CloudTrail は、CodeBuild コンソールからのコールや、CodeBuild API へのコード呼び出しを含む、CodeBuild のすべての API コールをイベントとしてキャプチャします。

証跡を作成する場合は、S3 バケットへの CloudTrail イベント (CodeBuild のイベントなど) の継続的な配信を有効にすることができます。

証跡を設定しない場合でも、CloudTrail コンソールの [Event history (イベント履歴)] で最新のイベントを表示できます。

CloudTrail によって収集された情報を使用して、CodeBuild に対するリクエスト、リクエスト元の IP アドレス、リクエスト者、リクエスト日時などの詳細を確認できます。https://docs.aws.amazon.com/ja_jp/codebuild/latest/userguide/cloudtrail.html

問29の正解

B. --endpoint-url 引数

たとえば、米国東部 (バージニア北部) リージョン で連邦情報処理標準 (FIPS) エンドポイントを使用して、プロジェクトビルド名のリストを取得するには、このコマンドを実行します。

aws codebuild list-projects --endpoint-url https://codebuild-fips.us-east-1.amazonaws.com問30の正解

C. ヘルスエージェントをEC2にインストール

環境内で実行されている Amazon EC2 インスタンスに関する詳細なヘルス情報を提供するため、Elastic Beanstalk は、拡張ヘルスをサポートする各プラットフォームのバージョンの Amazon マシンイメージ (AMI) にヘルスエージェントを含めます。

状態エージェントは、ウェブサーバーログとシステムメトリクスをモニタリングして、Elastic Beanstalk サービスに中継します。

Elastic Beanstalk は、これらのメトリクスを Elastic Load Balancing および Amazon EC2 Auto Scaling のデータと共に分析し、環境の状態に関する全体像を提示します。

https://docs.aws.amazon.com/ja_jp/elasticbeanstalk/latest/dg/health-enhanced.html問31の正解

D. Immutable

Immutable (変更不可) – 低速のデプロイ方法。

既存のインスタンスを更新するのではなく、常に新しいアプリケーションバージョンを新しいインスタンスにデプロイします。また、デプロイが失敗した場合に迅速かつ安全にロールバックできるという追加の利点もあります。

この方法では、Elastic Beanstalk は変更不可の更新を実行してアプリケーションをデプロイします。

変更不可能な更新では、環境内で 2 番目の Auto Scaling グループが起動し、新しいインスタンスがヘルスチェックに合格するまで、新しいバージョンが旧バージョンと並行してトラフィックを提供します。問32の正解

B. cron.yaml

ソースバンドルで cron.yaml という名前のファイルに定期的なタスクを定義し、定期的な間隔でワーカー環境のキューにジョブを自動的に追加できます。

たとえば、次の cron.yaml ファイルは 2 つの定期的なタスクを作成します。

最初のタスクは 12 時間ごとに実行され、2 番目のタスクは毎日午後 11 時 (UTC) に実行されます。version: 1 cron: - name: "backup-job" url: "/backup" schedule: "0 */12 * * *" - name: "audit" url: "/audit" schedule: "0 23 * * *"問33の正解

B. アプリケーションにアプリケーションバージョンライフサイクルポリシーを適用する

アプリケーションにアプリケーションバージョンライフサイクルポリシーを適用することで、クォータに到達するのを回避できます。ライフサイクルポリシーにより、古いアプリケーションバージョンを削除するか、アプリケーションの合計数が指定した数を超えた場合にアプリケーションバージョンを削除するよう Elastic Beanstalk に指示されます。

https://docs.aws.amazon.com/ja_jp/elasticbeanstalk/latest/dg/applications-lifecycle.html問34の正解

D. env.yaml

このファイル形式には環境グループのサポートが含まれます。グループを使用するには、マニフェスト内の環境の名前の末尾に +記号を指定します。環境を作成あるいは更新する場合、グループ名を --group-name (AWS CLI) または --env-group-suffix (EB CLI) と指定します。

次の例では、マニフェストが、ウェブサーバー環境に依存しているワーカー環境のコンポーネントへのリンクを持つウェブサーバー環境を定義します。マニフェストは、グループを使用して同じソースバンドルで複数の環境を作成することを許可します。~/myapp/frontend/env.yamlAWSConfigurationTemplateVersion: 1.1.0.0 SolutionStack: 64bit Amazon Linux 2015.09 v2.0.6 running Multi-container Docker 1.7.1 (Generic) OptionSettings: aws:elasticbeanstalk:command: BatchSize: '30' BatchSizeType: Percentage aws:elasticbeanstalk:sns:topics: Notification Endpoint: me@example.com aws:elb:policies: ConnectionDrainingEnabled: true ConnectionDrainingTimeout: '20' aws:elb:loadbalancer: CrossZone: true aws:elasticbeanstalk:environment: ServiceRole: aws-elasticbeanstalk-service-role aws:elasticbeanstalk:application: Application Healthcheck URL: / aws:elasticbeanstalk:healthreporting:system: SystemType: enhanced aws:autoscaling:launchconfiguration: IamInstanceProfile: aws-elasticbeanstalk-ec2-role InstanceType: t2.micro EC2KeyName: workstation-uswest2 aws:autoscaling:updatepolicy:rollingupdate: RollingUpdateType: Health RollingUpdateEnabled: true Tags: Cost Center: WebApp Dev CName: front-A08G28LG+ EnvironmentName: front+ EnvironmentLinks: "WORKERQUEUE" : "worker+"https://docs.aws.amazon.com/ja_jp/elasticbeanstalk/latest/dg/environment-cfg-manifest.html