- 投稿日:2020-06-30T23:58:06+09:00

Kabaneroを使ったアプリケーションの開発フローを確認してみた。

はじめに

勉強用にKabaneroを使ったアプリケーションの開発フロー(ローカル環境はDocker、本番環境はOpenShift)を作りながら動作確認した時の内容をまとめてみました。

Kabaneroとは

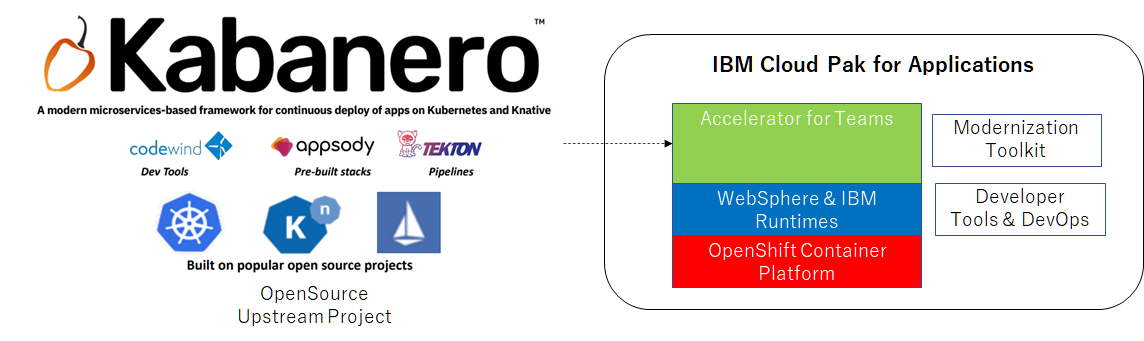

Kabaneroは、マイクロサービスベースのフレームワークで、開発者、アーキテクト、および運用チームがより迅速に連携できるしくみを作るIBM発のOSSのプロジェクトです。

Kabaneroは IBM Cloud Pak for ApplicationsにAccelerator for Teamsという名称で同梱され主要な機能になっています。

Kabanero がアップストリームプロジェクトで Kabanero → Cloud Pak for Applications(Accelerator for Teams)の順番でリリースされます。Appsody

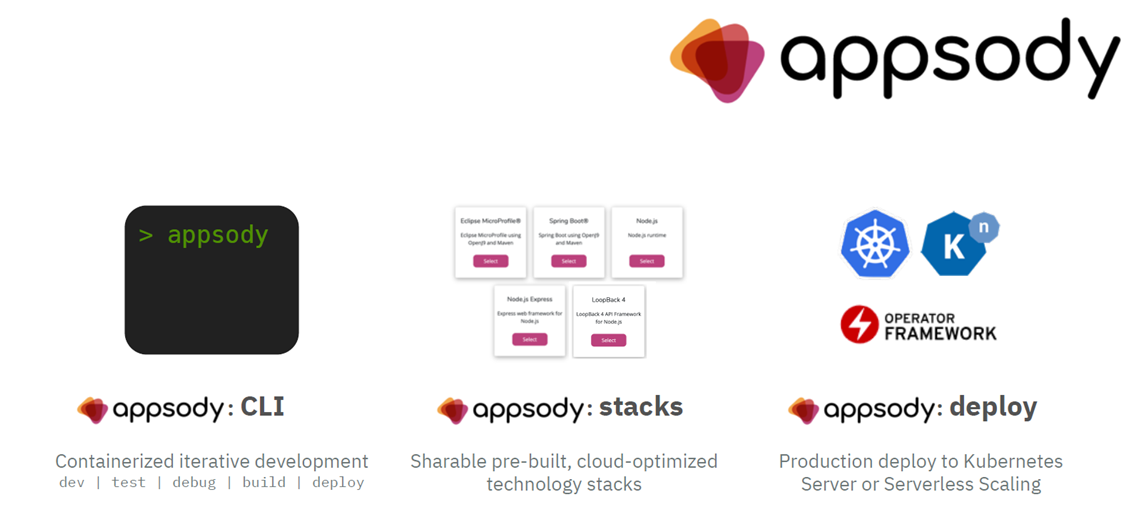

KabaneroのアンブレラプロジェクトであるappsodyがDockerの開発ライフサイクルを抽象化しています。

そのため、開発者はdockerのコマンドやDockerfileなど知らなくても開発することができます。例えば、

- appsody cliコマンドを使ってDockerを使ったローカル環境での開発からKubernetes、OpenShiftへのデプロイまで制御します。

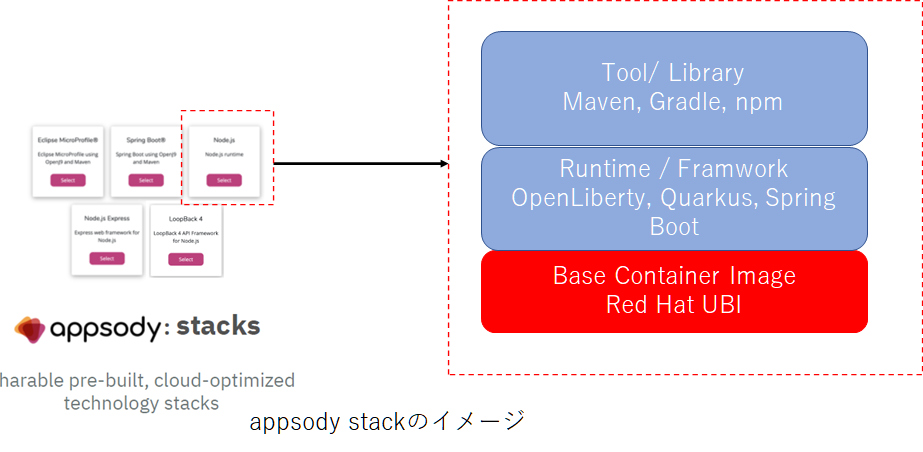

- stackというNode.js、Eclipse Microprofile、Quarkus、Spring Boot などのオープン・ソースのランタイムとフレームワークに対応する事前構成されたテンプレート(ベースコンテナイメージはRHEL8などのUBIイメージ)用意されています。

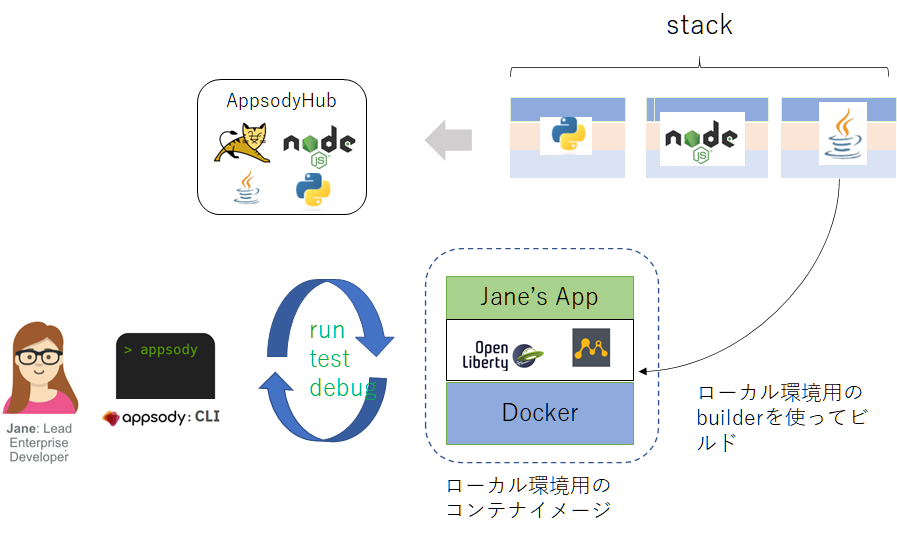

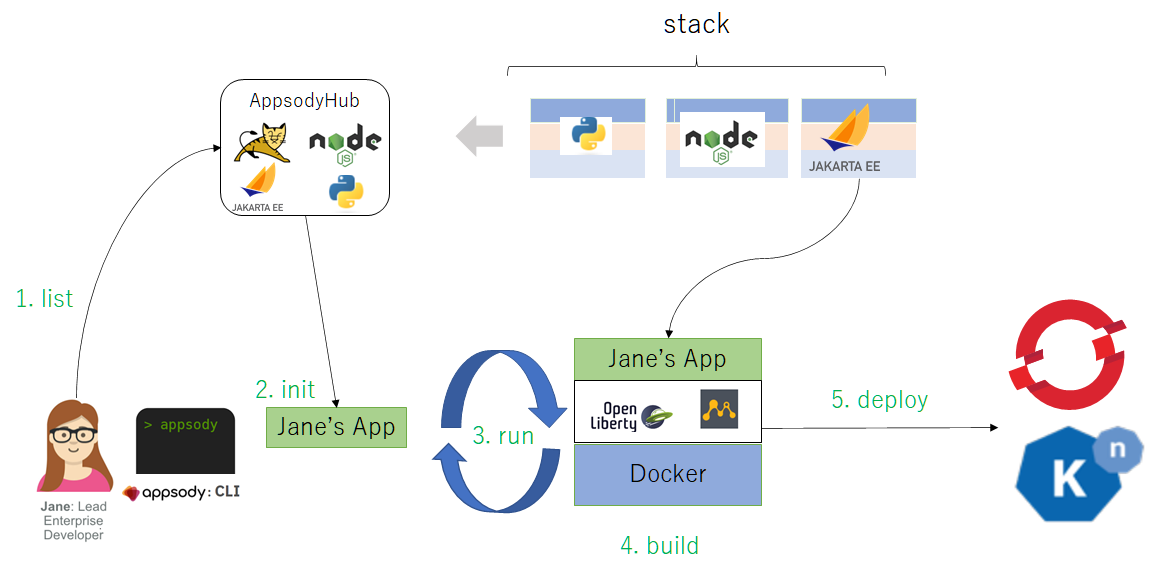

Kabaneroを使った開発者のワークフロー

では、Kabaneroを使うと開発者のワークフローはどのように変わるのでしょうか

フロー図に沿って、手順を確認していきたいと思います。

- 前提

- appsodyがインストールされていること

- ローカル環境にDockerがインストールされていること

- (本番環境のリリース用)OpenShiftに Kabaneroがインストールされていること

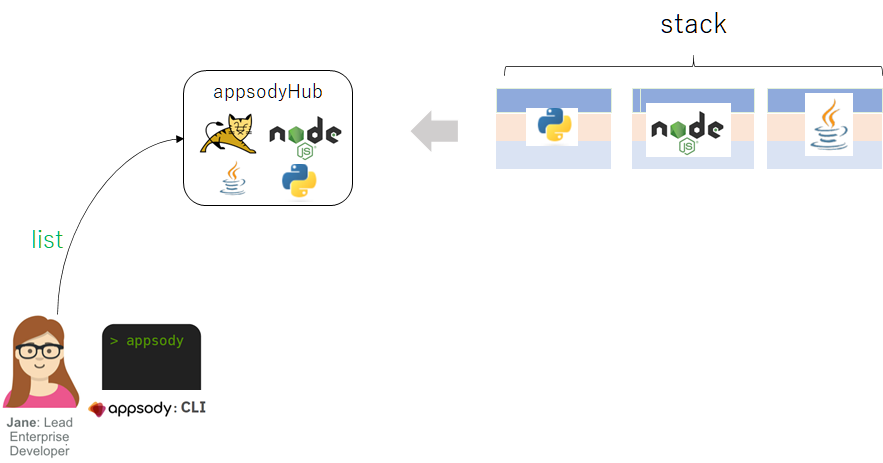

Appsody Hubから stackの一覧を取得

開発者のJaneは appsody listコマンドを使用して、利用できる stackの一覧を取得します。

appsody list REPO ID VERSION TEMPLATES DESCRIPTION kabanero java-microprofile [Deprecated] 0.2.27 *default Eclipse MicroProfile on Open Liberty & OpenJ9 using Maven kabanero java-openliberty 0.2.3 *default Open Liberty & OpenJ9 using Maven kabanero java-spring-boot2 0.3.29 *default, kafka, kotlin Spring Boot using OpenJ9 and Maven kabanero nodejs 0.3.6 *simple Runtime for Node.js applications kabanero nodejs-express 0.4.8 kafka, scaffold, *simple Express web framework for Node.jsREPO列がリポジトリ名、IDが stack名、TEMPLATESはアプリケーションのソースコードのテンプレート名です。

appsodyのプロジェクトの作成

appsody listコマンドで出力されたstackの中から、今回は java-openliberty stackを使って開発したいと思います。

まず、プロジェクトの保存先のディレクトリを作成します。

mkdir sample-application cd sample-applicationそして、appsody init "stack名"を実行して、開発環境を作成します。

# appsody init kabanero/java-openliberty Checking stack requirements... Docker requirements met Appsody requirements met Running appsody init... Downloading java-openliberty template project from https://github.com/appsody/stacks/releases/download/java-openliberty-v0.2.12/incubator.java-openlibert y.v0.2.12.templates.default.tar.gz Download complete. Extracting files from /root/sample-application/java-openliberty.tar.gz Setting up the development environment Your Appsody project name has been set to sample-application Pulling docker image docker.io/appsody/java-openliberty:0.2 Running command: docker pull docker.io/appsody/java-openliberty:0.2 0.2: Pulling from appsody/java-openliberty ee2244abc66f: Pulling fs layer befb03b11956: Pulling fs layer 4d3fb84d4d60: Pulling fs layer d0aba8033c85: Pull complete e7e883ba65bb: Pull complete Digest: sha256:4dff3ca3d27b910b8dacf84895f5763d96df9671b7bbd5694ae14b4624d47dbd Status: Downloaded newer image for appsody/java-openliberty:0.2 docker.io/appsody/java-openliberty:0.2 [Warning] The stack image does not contain APPSODY_PROJECT_DIR. Using /project Running command: docker run --rm --entrypoint /bin/bash docker.io/appsody/java-openliberty:0.2 -c "find /project -type f -name .appsody-init.sh" Extracting project from development environment [Warning] The stack image does not contain APPSODY_PROJECT_DIR. Using /project Running command: docker create --name sample-application-extract -v /root/.m2/repository:/mvn/repository -v /root/sample-application/:/project/user-app docker.io/appsody/java-openliberty:0.2 Running command: docker cp sample-application-extract:/project /root/.appsody/extract/sample-application Project extracted to /root/sample-application/.appsody_init Running command: docker rm sample-application-extract -f Running command: ./.appsody-init.sh [InitScript] [INFO] Scanning for projects... [InitScript] [INFO] [InitScript] [INFO] --------------------< dev.appsody:java-openliberty >-------------------- [InitScript] [INFO] Building java-openliberty 0.2.14 [InitScript] [INFO] --------------------------------[ pom ]--------------------------------- [InitScript] [INFO] [InitScript] [INFO] --- maven-enforcer-plugin:3.0.0-M3:enforce (default-cli) @ java-openliberty --- [InitScript] [INFO] Skipping Rule Enforcement. [InitScript] [INFO] [InitScript] [INFO] --- maven-install-plugin:2.4:install (default-install) @ java-openliberty --- [InitScript] [INFO] Installing /root/sample-application/.appsody_init/pom.xml to /root/.m2/repository/dev/appsody/java-openliberty/0.2.14/java-openliberty-0.2.14.pom [InitScript] [INFO] ------------------------------------------------------------------------ [InitScript] [INFO] BUILD SUCCESS [InitScript] [INFO] ------------------------------------------------------------------------ [InitScript] [INFO] Total time: 1.354 s [InitScript] [INFO] Finished at: 2020-07-01T03:24:37+09:00 [InitScript] [INFO] ------------------------------------------------------------------------ Successfully added your project to /root/.appsody/project.yaml Your Appsody project ID has been set to 20200701032437.87801097 Successfully initialized Appsody project with the kabanero/java-openliberty stack and the default template.initが終了した後、sample-applicationディレクトリ構成は以下の通りです。

. ├── mvnw ├── mvnw.cmd ├── pom.xml └── src ├── main │ ├── java │ │ └── dev │ │ └── appsody │ │ └── starter │ │ ├── health │ │ │ ├── StarterLivenessCheck.java │ │ │ └── StarterReadinessCheck.java │ │ ├── StarterApplication.java │ │ └── StarterResource.java │ ├── liberty │ │ └── config │ │ ├── configDropins │ │ │ └── defaults │ │ │ └── quick-start-security.xml │ │ └── server.xml │ └── webapp │ ├── index.html │ └── WEB-INF │ └── beans.xml └── test └── java └── it └── dev └── appsody └── starter ├── EndpointTest.java └── HealthEndpointTest.java開発者Janeは、この構成をベースに開発を進めます。

ローカル環境でのアプリケーションの動作確認

開発者Janeは、アプリケーションの開発の途中、任意のタイミングでアプリケーションを起動して動作確認するのには

appsody では run / test / debug コマンドを使用てJaneのアプリケーションを起動します。では、 appsody run コマンドを実行して、アプリケーションを起動します。

# appsody run Running development environment... Pulling docker image docker.io/appsody/java-openliberty:0.2 Running command: docker pull docker.io/appsody/java-openliberty:0.2 0.2: Pulling from appsody/java-openliberty Digest: sha256:4dff3ca3d27b910b8dacf84895f5763d96df9671b7bbd5694ae14b4624d47dbd Status: Image is up to date for appsody/java-openliberty:0.2 docker.io/appsody/java-openliberty:0.2 [Warning] The stack image does not contain APPSODY_DEPS Running command: docker run --rm -p 7777:7777 -p 9080:9080 -p 9443:9443 --name sample-application -u 0:0 -e "APPSODY_USER=0" -e "APPSODY_GROUP=0" -v /root/.m2/repository:/mvn/repository -v /root/sample-application/:/project/user-app -v appsody-controller-0.3.5:/.appsody -t --entrypoint /.appsody/appsody-controller docker.io/appsody/java-openliberty:0.2 "--mode=run" [Container] Running APPSODY_PREP command: /project/run-stack.sh prep [Container] Installing parent dev.appsody:java-openliberty:0.2.14 [Container] [INFO] Scanning for projects... [Container] [INFO] [Container] [INFO] --------------------< dev.appsody:java-openliberty >-------------------- [Container] [INFO] Building java-openliberty 0.2.14 [Container] [INFO] --------------------------------[ pom ]--------------------------------- [Container] [INFO] [Container] [INFO] --- maven-enforcer-plugin:3.0.0-M3:enforce (default-cli) @ java-openliberty --- [Container] [INFO] Skipping Rule Enforcement. [Container] [INFO] [Container] [INFO] --- maven-install-plugin:2.4:install (default-install) @ java-openliberty --- [Container] [INFO] Installing /project/user-app/../pom.xml to /mvn/repository/dev/appsody/java-openliberty/0.2.14/java-openliberty-0.2.14.pom [Container] [INFO] ------------------------------------------------------------------------ [Container] [INFO] BUILD SUCCESS [Container] [INFO] ------------------------------------------------------------------------ [Container] [INFO] Total time: 0.932 s (省略) [Container] [INFO] [AUDIT ] CWWKE0001I: The server defaultServer has been launched. [Container] [INFO] [AUDIT ] CWWKG0093A: Processing configuration drop-ins resource: /opt/ol/wlp/usr/servers/defaultServer/configDropins/defaults/quick-start-security.xml [Container] [INFO] [AUDIT ] CWWKZ0058I: Monitoring dropins for applications. [Container] [INFO] [AUDIT ] CWPKI0820A: The default keystore has been created using the 'keystore_password' environment variable. [Container] [INFO] [AUDIT ] CWWKS4104A: LTPA keys created in 3.284 seconds. LTPA key file: /opt/ol/wlp/usr/servers/defaultServer/resources/security/ltpa.keys [Container] [INFO] [AUDIT ] CWPKI0803A: SSL certificate created in 4.596 seconds. SSL key file: /opt/ol/wlp/usr/servers/defaultServer/resources/security/key.p12 [Container] [INFO] [AUDIT ] CWWKT0016I: Web application available (default_host): http://023d8b3431cd:9080/health/ [Container] [INFO] [AUDIT ] CWWKT0016I: Web application available (default_host): http://023d8b3431cd:9080/ibm/api/ [Container] [INFO] [AUDIT ] CWWKT0016I: Web application available (default_host): http://023d8b3431cd:9080/jwt/ [Container] [INFO] [AUDIT ] CWWKT0016I: Web application available (default_host): http://023d8b3431cd:9080/openapi/ui/ [Container] [INFO] [AUDIT ] CWWKT0016I: Web application available (default_host): http://023d8b3431cd:9080/metrics/ [Container] [INFO] [AUDIT ] CWWKT0016I: Web application available (default_host): http://023d8b3431cd:9080/openapi/ [Container] [INFO] [AUDIT ] CWWKT0016I: Web application available (default_host): http://023d8b3431cd:9080/ [Container] [INFO] [AUDIT ] CWWKZ0001I: Application starter-app started in 18.902 seconds. [Container] [INFO] [AUDIT ] CWWKF0012I: The server installed the following features: [appSecurity-2.0, cdi-2.0, concurrent-1.0, distributedMap-1.0, jaxrs-2.1, jaxrsClient-2.1, jndi-1.0, json-1.0, jsonb-1.0, jsonp-1.1, jwt-1.0, microProfile-3.2, mpConfig-1.3, mpFaultTolerance-2.0, mpHealth-2.1, mpJwt-1.1, mpMetrics-2.2, mpOpenAPI-1.1, mpOpenTracing-1.3, mpRestClient-1.3, opentracing-1.3, servlet-4.0, ssl-1.0]. [Container] [INFO] [AUDIT ] CWWKF0011I: The defaultServer server is ready to run a smarter planet. The defaultServer server started in 49.562 seconds. [Container] [INFO] CWWKM2015I: Match number: 1 is [6/30/20 21:47:36:813 UTC] 0000002e com.ibm.ws.kernel.feature.internal.FeatureManager A CWWKF0011I: The defaultServer server is ready to run a smarter planet. The defaultServer server started in 49.562 seconds.. [Container] [INFO] Tests will run automatically when changes are detected. [Container] [INFO] Source compilation was successful. [Container] [INFO] Tests compilation was successful. [Container] [INFO] [AUDIT ] CWWKT0017I: Web application removed (default_host): http://023d8b3431cd:9080/ [Container] [INFO] [AUDIT ] CWWKZ0009I: The application starter-app has stopped successfully. [Container] [INFO] Running unit tests... [Container] [INFO] Unit tests finished. [Container] [INFO] Waiting up to 30 seconds to find the application start up or update message... [Container] [INFO] CWWKM2010I: Searching for (CWWKZ0001I.*|CWWKZ0003I.*starter-app) in /opt/ol/wlp/usr/servers/defaultServer/logs/messages.log. This search will timeout after 30 seconds. [Container] [INFO] CWWKM2015I: Match number: 1 is [6/30/20 21:47:36:038 UTC] 00000039 com.ibm.ws.app.manager.AppMessageHelper A CWWKZ0001I: Application starter-app started in 18.902 seconds.. [Container] [INFO] Running integration tests... [Container] [INFO] [AUDIT ] CWWKT0016I: Web application available (default_host): http://023d8b3431cd:9080/ [Container] [INFO] [AUDIT ] CWWKZ0003I: The application starter-app updated in 2.628 seconds. [Container] [INFO] [Container] [INFO] ------------------------------------------------------- [Container] [INFO] T E S T S [Container] [INFO] ------------------------------------------------------- [Container] [INFO] Running it.dev.appsody.starter.HealthEndpointTest [Container] [INFO] Tests run: 2, Failures: 0, Errors: 0, Skipped: 0, Time elapsed: 2.048 s - in it.dev.appsody.starter.HealthEndpointTest [Container] [INFO] Running it.dev.appsody.starter.EndpointTest [Container] [INFO] [WARNING ] CWMOT0010W: OpenTracing cannot track JAX-RS requests because an OpentracingTracerFactory class was not provided or client libraries for tracing backend are not in the class path. [Container] [INFO] Tests run: 1, Failures: 0, Errors: 0, Skipped: 0, Time elapsed: 1.056 s - in it.dev.appsody.starter.EndpointTest [Container] [INFO] [Container] [INFO] Results: [Container] [INFO] [Container] [INFO] Tests run: 3, Failures: 0, Errors: 0, Skipped: 0 [Container] [INFO] [Container] [INFO] Integration tests finished.ログからは、docker pull、maven、OpenLibertyの起動、IntegrationTestの実行されているのがわかりますが、

OpenLibertyが起動したので、 起動確認として、healthチェックがupになっているのを確認します。# curl http://localhost:9080/health {"checks":[{"data":{},"name":"StarterLivenessCheck","status":"UP"},{"data":{},"name":"StarterReadinessCheck","status":"UP"}],"status":"UP"}これで、ローカル環境でのアプリケーションの起動を確認することができました。

Janeは開発が終了まで、ソースコードの作成とappsody runコマンドで動作確認を繰り返すことになります。OpenShiftへリリースするためのアプリケーションのビルド

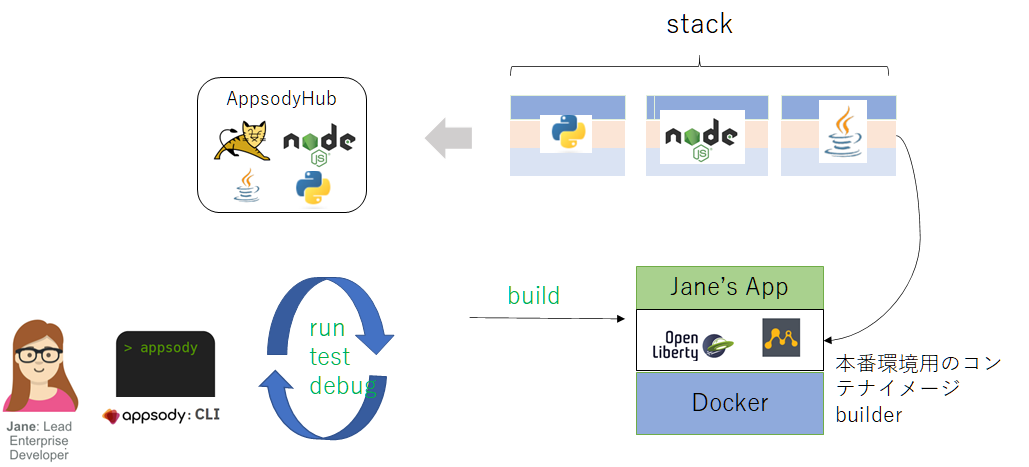

Janeはアプリケーションの開発が終了したので、OpenShiftへデプロイします。

まずは、appsody buildコマンドを実行して、本番環境用のコンテナイメージをビルドします。

appsody runの時はローカル環境用のbuilderを使って、コンテナイメージを生成していましたが、appsody buildの場合は本番環境のbuilderを使ってコンテナイメージを生成します。# appsody build Extracting project from development environment Pulling docker image docker.io/appsody/java-openliberty:0.2 Running command: docker pull docker.io/appsody/java-openliberty:0.2 0.2: Pulling from appsody/java-openliberty Digest: sha256:4dff3ca3d27b910b8dacf84895f5763d96df9671b7bbd5694ae14b4624d47dbd Status: Image is up to date for appsody/java-openliberty:0.2 docker.io/appsody/java-openliberty:0.2 [Warning] The stack image does not contain APPSODY_PROJECT_DIR. Using /project Running command: docker create --name sample-application-extract -v /root/.m2/repository:/mvn/repository -v /root/sample-application/:/project/user-app docker.io/appsody/java-openliberty:0.2 Running command: docker cp sample-application-extract:/project /root/.appsody/extract/sample-application Project extracted to /root/.appsody/extract/sample-application Running command: docker rm sample-application-extract -f (省略) [Docker] Sending build context to Docker daemon 706kB [Docker] Step 1/62 : FROM kabanero/ubi8-maven:0.9.0 as compile [Docker] 0.9.0: Pulling from kabanero/ubi8-maven (省略) [Docker] Removing intermediate container 587544680ab9 [Docker] ---> 6cb69d5ff953 [Docker] Successfully built 6cb69d5ff953 [Docker] Successfully tagged dev.local/sample-application:latest Built docker image dev.local/sample-application Running command: docker create --name sample-application-extract docker.io/appsody/java-openliberty:0.2 Running command: docker cp sample-application-extract:/config/app-deploy.yaml /root/sample-application/app-deploy.yaml Running command: docker rm sample-application-extract -f Created deployment manifest: /root/sample-application/app-deploy.yamlOpenShiftへのデプロイは OpenShiftにインストールされた Appsody Operatorがアプリケーションをデプロイします。

最後に作成されたapp-deploy.yamlは、Appsody Operatorに渡すためのmanifestです。

- app-deploy.yaml

apiVersion: openliberty.io/v1beta1 kind: OpenLibertyApplication metadata: annotations: architecture: x86_64 authoritative-source-url: registry.access.redhat.com build-date: 2020-03-31T14:54:13.907559 commit.stack.appsody.dev/contextDir: /incubator/java-openliberty commit.stack.appsody.dev/date: Thu Jun 4 13:29:00 2020 +0100 commit.stack.appsody.dev/message: 'java-openliberty: define APPSODY_DEBUG_PORT (#818)' description: Eclipse MicroProfile & Jakarta EE on Open Liberty & OpenJ9 using Maven distribution-scope: public image.opencontainers.org/created: "2020-07-01T07:13:29+09:00" k8s.io/description: The Universal Base Image is designed and engineered to be the base layer for all of your containerized applications, middleware and utilities. This base image is freely redistributable, but Red Hat only supports Red Hat technologies through subscriptions for Red Hat products. This image is maintained by Red Hat and updated regularly. k8s.io/display-name: Red Hat Universal Base Image 8 maintainer: Red Hat, Inc. name: java-openliberty openshift.io/expose-services: "" openshift.io/tags: base rhel8 redhat.com/build-host: cpt-1007.osbs.prod.upshift.rdu2.redhat.com redhat.com/component: ubi8-container redhat.com/license_terms: https://www.redhat.com/en/about/red-hat-end-user-license-agreements#UBI release: "408" stack.appsody.dev/authors: Mike Andrasak <uberskigeek>, Andy Mauer <ajm01>, Scott Kurz <scottkurz>, Adam Wisniewski <awisniew90> stack.appsody.dev/configured: docker.io/appsody/java-openliberty:0.2 stack.appsody.dev/created: "2020-06-04T12:31:59Z" stack.appsody.dev/description: Eclipse MicroProfile & Jakarta EE on Open Liberty & OpenJ9 using Maven stack.appsody.dev/digest: sha256:4dff3ca3d27b910b8dacf84895f5763d96df9671b7bbd5694ae14b4624d47dbd stack.appsody.dev/documentation: https://github.com/appsody/stacks/tree/master/incubator/java-openliberty/README.md stack.appsody.dev/licenses: Apache-2.0 stack.appsody.dev/revision: 1b105b4891a3edef718d668271da30086214dd84 stack.appsody.dev/source: https://github.com/appsody/stacks/tree/master/incubator/java-openliberty/image stack.appsody.dev/tag: docker.io/appsody/java-openliberty:0.2.14 stack.appsody.dev/title: Open Liberty stack.appsody.dev/url: https://github.com/appsody/stacks/tree/master/incubator/java-openliberty summary: Open Liberty url: https://access.redhat.com/containers/#/registry.access.redhat.com/ubi8/images/8.1-408 vcs-ref: 26f36bfa3e3a04c8c866b250924c1aefc34f01c9 vcs-type: git vendor: Open Liberty version: 0.2.14 creationTimestamp: null labels: image.opencontainers.org/title: sample-application stack.appsody.dev/id: java-openliberty stack.appsody.dev/version: 0.2.14 name: sample-application namespace: sampleapps1 spec: applicationImage: dev.local/sample-application createKnativeService: false expose: true livenessProbe: failureThreshold: 12 httpGet: path: /health/live port: 9080 initialDelaySeconds: 5 periodSeconds: 2 readinessProbe: failureThreshold: 12 httpGet: path: /health/ready port: 9080 initialDelaySeconds: 5 periodSeconds: 2 timeoutSeconds: 1 service: annotations: prometheus.io/scrape: "true" port: 9080 type: NodePort version: 1.0.0アプリケーションのOpenShiftへのデプロイ

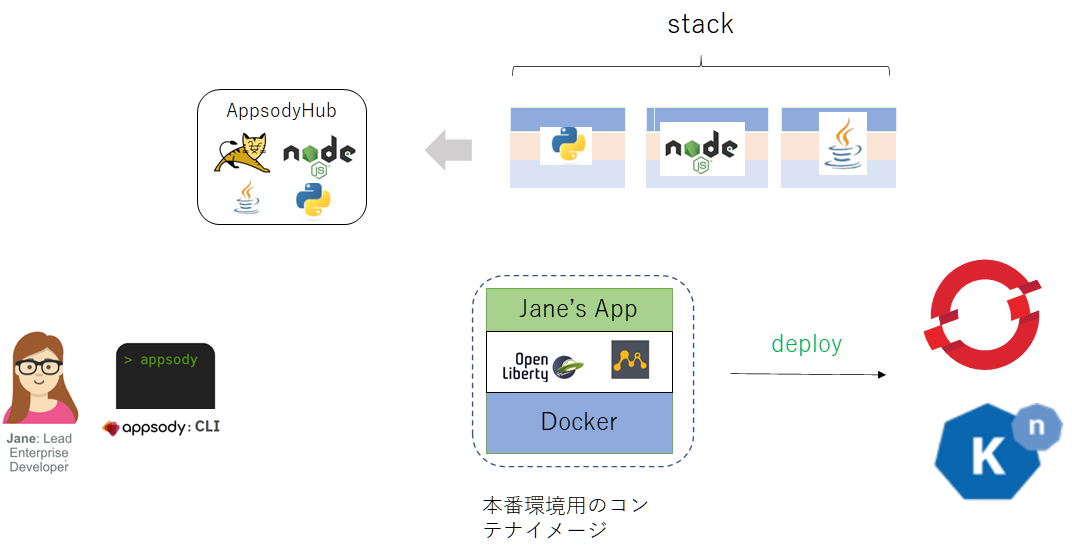

buildが終了すると本番環境のコンテナイメージが生成されます。このイメージをOpenShiftにデプロイするためには appsody deployコマンドでデプロイします。

その前に、OpenShiftの環境を準備します。

プロジェクト(namespace)の作成

アプリケーションをデプロイするためのプロジェクト( sampleapps )を作成します。

# oc new-project sampleapps Now using project "sampleapps" on server "https://api.lab.example.com:6443". You can add applications to this project with the 'new-app' command. For example, try: oc new-app ruby~https://github.com/sclorg/ruby-ex.git to build a new example application in Python. Or use kubectl to deploy a simple Kubernetes application: kubectl create deployment hello-node --image=gcr.io/hello-minikube-zero-install/hello-node現時点では、 sampleappsプロジェクトには何もリソースはありません。

# oc get all -n sampleapps No resources found in sampleapps namespace.次に"oc get csv"コマンドを実行すると、sampleappsプロジェクトでは以下のOperatorが使えるようになっていますが、

このOperatorは、KabaneroをInstallしたときに導入されたOperatorが、sampleappsプロジェクトにも展開されています。# oc get csv -n sampleapps NAME DISPLAY VERSION REPLACES PHASE appsody-operator.v0.5.1 Appsody Operator 0.5.1 Succeeded elasticsearch-operator.4.3.26-202006160135 Elasticsearch Operator 4.3.26-202006160135 elasticsearch-operator.4.3.25-202006081335 Succeeded jaeger-operator.v1.17.3 Red Hat OpenShift Jaeger 1.17.3 jaeger-operator.v1.17.2 Succeeded kiali-operator.v1.12.13 Kiali Operator 1.12.13 kiali-operator.v1.12.12 Succeeded open-liberty-operator.v0.5.1 Open Liberty Operator 0.5.1 Succeeded openshift-pipelines-operator.v0.11.2 OpenShift Pipelines Operator 0.11.2 Succeeded serverless-operator.v1.7.1 OpenShift Serverless Operator 1.7.1 Succeeded servicemeshoperator.v1.1.3 Red Hat OpenShift Service Mesh 1.1.3 servicemeshoperator.v1.1.2.3 Succeeded次に、OpenShiftの内部レジストリに本番環境用のコンテナイメージpushするために、内部レジストリにログインします。

ログインするために必要な内部レジストリのURLを変数HOSTに格納します。

HOST=$(oc get route default-route -n openshift-image-registry --template='{{ .spec.host }}') # echo ${HOST} default-route-openshift-image-registry.apps.lab.example.comそして、内部レジストリにログインして、ローカル環境からOpenShiftにコンテナイメージをpushできるようにします。

# docker login -u kubeadmin -p $(oc whoami -t) $HOST WARNING! Using --password via the CLI is insecure. Use --password-stdin. WARNING! Your password will be stored unencrypted in /root/.docker/config.json. Configure a credential helper to remove this warning. See https://docs.docker.com/engine/reference/commandline/login/#credentials-store Login Succeeded最後に appsody deployコマンドを使用して、OpenShiftにデプロイします。

# appsody deploy --tag sampleapps/sample-application:v1 --push-url $HOST --push --pull-url docker-registry.default.svc:5000 --namespace sampleapps-- tag プロジェクト名/コンテナイメージ名:tag

--push-url $HOST --push は ローカル環境からpushするためにアドレスを記述

--pull-url は OpenShift内部で、デプロイするのに pullするために必要なURLを記述デプロイが終了して、"oc get all -n sampleapps" コマンドを実行すると podが起動しているのが確認できます。

# oc get all -n sampleapps NAME READY STATUS RESTARTS AGE pod/sample-application-6d56c87cdf-fhrs2 0/1 Running 0 42s NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/sample-application NodePort 172.30.145.68 <none> 9080:30957/TCP 43s NAME READY UP-TO-DATE AVAILABLE AGE deployment.apps/sample-application 0/1 1 0 42s NAME DESIRED CURRENT READY AGE replicaset.apps/sample-application-6d56c87cdf 1 1 0 42s NAME IMAGE REPOSITORY TAGS UPDATED imagestream.image.openshift.io/sample-application default-route-openshift-image-registry.apps.lab.example.com/sampleapps/sample-application latest 2 minutes ago NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD route.route.openshift.io/sample-application sample-application-sampleapps.apps.lab.example.com sample-application 9080-tcp None外部からcurlでhealthチェックのURLにアクセスすると statusがupになってるのが確認できました。

# curl http://sample-application-sampleapps.apps.lab.example.com/health {"checks":[{"data":{},"name":"StarterLivenessCheck","status":"UP"},{"data":{},"name":"StarterReadinessCheck","status":"UP"}],"status":"UP"}Kabaneroを使った開発フローのまとめ

これまでのkabaneroを使ったアプリケーションの開発フローをまとめると下図の様ながれになります。

これまでの流れから、appsody cliのコマンドを使うとdockerコマンドが抽象化されているので、開発者はdockerの作法知らなくても、開発できそうです。

また、stackをカスタマイズすると、それぞれの組織にあったstackもできそうです。

そして、5. deployでは、appsody operatorがアプリケーションをOpenShiftにデプロイしているのは初見でした。

もう少し勉強をすすめていきたいと思います。

- 投稿日:2020-06-30T23:28:00+09:00

「Docker/Kubernetes 実践コンテナ開発入門」の7章をHelm v3でやってみた

はじめに

「Docker/Kubernetes 実践コンテナ開発入門」を読みながらKubernetesを勉強していたのですが、コンテナ技術の発展が早く、出版が2018年8月ということで内容が少し古くなってきました。特に7章3節のHelmの解説では、Helmのバージョンがv31に上がったことによるコマンド変更があり、Helm v3を使用する場合には手順がそのまま使えなくなっています。この記事ではHelm v3を使用した場合の手順について解説します。

前提

- 「Docker/Kubernetes 実践コンテナ開発入門」を購入し、読んでいる方向けです。

- あくまで差分の紹介なので、技術の解説等は本を読んでください。

環境

- mac OS Catalina 10.15.5

- プロセッサ: 2.3 GHz デュアルコアIntel Core i5

- メモリ: 8 GB 2133 MHz LPDDR3

dockerはdocker for macを使用してローカルで実行しました。

$ docker --version Docker version 19.03.8, build afacb8b $ kubectl version Client Version: version.Info{Major:"1", Minor:"18", GitVersion:"v1.18.4", GitCommit:"c96aede7b5205121079932896c4ad89bb93260af", GitTreeState:"clean", BuildDate:"2020-06-18T02:59:13Z", GoVersion:"go1.14.3", Compiler:"gc", Platform:"darwin/amd64"} Server Version: version.Info{Major:"1", Minor:"16+", GitVersion:"v1.16.6-beta.0", GitCommit:"e7f962ba86f4ce7033828210ca3556393c377bcc", GitTreeState:"clean", BuildDate:"2020-01-15T08:18:29Z", GoVersion:"go1.13.5", Compiler:"gc", Platform:"linux/amd64"}また、VS Codeでyamlを編集していたのですが、自動整形をした際の中括弧の挙動がおかしかったので、VS Code拡張機能の

vscode-helmをインストールしました。手順

Helmのセットアップ

kubectlをローカルkubernetesクラスタに切り替えておきます。

HomebrewでHelmをインストールします。$ brew install helm $ helm version version.BuildInfo{Version:"v3.2.4", GitCommit:"0ad800ef43d3b826f31a5ad8dfbb4fe05d143688", GitTreeState:"dirty", GoVersion:"go1.14.3"}v3でTillerサーバが廃止されたので、

helm initは不要です。

v2ではkubernetesクラスタ上にTillerサーバがデプロイされ、クライアントのhelmコマンドでTillerサーバのAPIを呼び出し、命令を受けたTillerサーバがkubernetesクラスタのAPIを呼び出すという流れになっていました。拡張性のある構成だとは思いますが、Tillerサーバ周りのサービス・アカウントの設定が複雑になるということで使い勝手が悪かったようです。v3 ではTillerサーバが廃止され、クライアントから直接kubernetesクラスタのAPIを呼び出すようになりました。マニフェストの生成もクライアントで行われるようになっています。詳細は下記のサイトをご覧ください。Helmの概念

v2とは違いstableリポジトリはデフォルトでは利用できなくなっています。次のようにすればstableリポジトリを追加できます。

$ helm repo add stable https://kubernetes-charts.storage.googleapis.com/stableリポジトリは将来廃止される予定で、分散型のリポジトリに移行するようです。

The stable repository is no longer added by default. This repository will be deprecated during the life of Helm v3 and we are now moving to a distributed model of repositories that can be searched by the Helm Hub.

Ref: https://helm.sh/blog/helm-v3-beta/リポジトリの検索は

helm searchで行いますが、repoとhubの2つで検索を指定します。hubの検索は一部のリポジトリのみが表示されます。そのリポジトリからChartを使用するには、関連するリポジトリをHelmリポジトリリストに追加する必要があります。$ helm search -h Search provides the ability to search for Helm charts in the various places they can be stored including the Helm Hub and repositories you have added. Use search subcommands to search different locations for charts. Usage: helm search [command] Available Commands: hub search for charts in the Helm Hub or an instance of Monocular repo search repositories for a keyword in charts Flags: ...Chartをインストールする

redmineをインストールします。

bitnamiリポジトリを追加します。一応リポジトリの情報を最新化しておきます。$ helm repo add bitnami https://charts.bitnami.com/bitnami $ helm repo updateインストールするChartの情報です。

$ helm show chart bitnami/redmine helm show chart bitnami/redmine apiVersion: v1 appVersion: 4.1.1 dependencies: - condition: mariadb.enabled name: mariadb repository: https://charts.bitnami.com/bitnami version: 7.x.x - condition: postgresql.enabled name: postgresql repository: https://charts.bitnami.com/bitnami version: 8.x.x description: A flexible project management web application. home: http://www.redmine.org/ icon: https://bitnami.com/assets/stacks/redmine/img/redmine-stack-220x234.png keywords: - redmine - project management - www - http - web - application - ruby - rails maintainers: - email: containers@bitnami.com name: Bitnami name: redmine sources: - https://github.com/bitnami/bitnami-docker-redmine version: 14.2.4インストールします。パラメータを

redmine.yamlで定義します。redmine.yamlredmineUsername: abeT redminePassword: abeT redmineLanguage: ja service: type: NodePortリリース名は

--nameで指定せず、helm installの直後に指定します。$ helm install -f redmine.yaml redmine bitnami/redmine NAME: redmine LAST DEPLOYED: Fri Jun 26 15:42:19 2020 NAMESPACE: default STATUS: deployed REVISION: 1 NOTES: 1. Get the Redmine URL: export NODE_PORT=$(kubectl get --namespace default -o jsonpath="{.spec.ports[0].nodePort}" services redmine) export NODE_IP=$(kubectl get nodes --namespace default -o jsonpath="{.items[0].status.addresses[0].address}") echo "Redmine URL: http://$NODE_IP:$NODE_PORT/" 2. Login with the following credentials echo Username: abeT echo Password: $(kubectl get secret --namespace default redmine -o jsonpath="{.data.redmine-password}" | base64 --decode)インストールされたものの一覧を表示します。

$ helm ls NAME NAMESPACE REVISION UPDATED STATUS CHART APP VERSION redmine default 1 2020-06-26 13:55:26.228257 +0900 JST deployed redmine-14.2.4 4.1.1作成されたリソースを確認します。

$ kubectl get service,deployment NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 24m service/redmine NodePort 10.97.203.207 <none> 80:30677/TCP 114s service/redmine-mariadb ClusterIP 10.110.204.194 <none> 3306/TCP 114s NAME READY UP-TO-DATE AVAILABLE AGE deployment.apps/redmine 1/1 1 1 114s

service/redmineがNodePortになっており、http://localhost:30677でredmineにアクセスできるようになっています。※ deployment.apps/redmineがREADYにならず、止まってしまう事象が発生しました。原因は不明ですが(多分メモリの不足?)、

Reset Kubernetes Clusterでクラスターを全削除してから実行するとうまくいく場合があります。アンインストール

次のコマンドでアンインストールを実行できます。v3ではデフォルトではリビジョンの記録が残りません。

--keep-historyを付与することで、リビジョンを残しておくことができます。$ helm uninstall redmine --keep-history release "redmine" uninstalledリビジョンを確認できます。

$ helm ls --all NAME NAMESPACE REVISION UPDATED STATUS CHART APP VERSION redmine default 1 2020-06-26 16:14:29.972481 +0900 JST uninstalled redmine-14.2.4 4.1.1ロールバックを実行します。

$ helm rollback redmine 1 Rollback was a success! Happy Helming!削除がロールバックされて、実行状態になっています。

$ helm ls NAME NAMESPACE REVISION UPDATED STATUS CHART APP VERSION redmine default 2 2020-06-29 14:21:46.552373 +0900 JST deployed redmine-14.2.4 4.1.1リビジョンの記録を残さないで削除するには

--keep-historyなしで削除します。$ helm uninstall redmine release "redmine" uninstalled $ helm ls --all NAME NAMESPACE REVISION UPDATED STATUS CHART APP VERSIONChartを自作する

Chartのテンプレートを作成します。

$ helm create echo Creating echo $ tree . . └── echo ├── Chart.yaml ├── charts ├── templates │ ├── NOTES.txt │ ├── _helpers.tpl │ ├── deployment.yaml │ ├── hpa.yaml │ ├── ingress.yaml │ ├── service.yaml │ ├── serviceaccount.yaml │ └── tests │ └── test-connection.yaml └── values.yaml 4 directories, 10 filesMacには標準で

treeコマンドは入っていないので、Homebrewでインストールしました。$ brew install treev2と比べると、次の3つファイルが増えています。これらのファイルは今回は使用しません。

- hpa.yaml # HorizontalPodAutoscalerのマニフェスト

- serviceaccount.yaml # ServiceAccountのマニフェスト

- test-connection.yaml # Chartをテストするのに使用する

Chartのテンプレートの構成はこちらを参照してください。

生成された

deployment.yamlの中身は次のようになっています。deployment.yamlapiVersion: apps/v1 kind: Deployment metadata: name: {{ include "echo.fullname" . }} labels: {{- include "echo.labels" . | nindent 4 }} spec: {{- if not .Values.autoscaling.enabled }} replicas: {{ .Values.replicaCount }} {{- end }} selector: matchLabels: {{- include "echo.selectorLabels" . | nindent 6 }} template: metadata: {{- with .Values.podAnnotations }} annotations: {{- toYaml . | nindent 8 }} {{- end }} labels: {{- include "echo.selectorLabels" . | nindent 8 }} spec: {{- with .Values.imagePullSecrets }} imagePullSecrets: {{- toYaml . | nindent 8 }} {{- end }} serviceAccountName: {{ include "echo.serviceAccountName" . }} securityContext: {{- toYaml .Values.podSecurityContext | nindent 8 }} containers: - name: {{ .Chart.Name }} securityContext: {{- toYaml .Values.securityContext | nindent 12 }} image: "{{ .Values.image.repository }}:{{ .Values.image.tag | default .Chart.AppVersion }}" imagePullPolicy: {{ .Values.image.pullPolicy }} ports: - name: http containerPort: 80 protocol: TCP livenessProbe: httpGet: path: / port: http readinessProbe: httpGet: path: / port: http resources: {{- toYaml .Values.resources | nindent 12 }} {{- with .Values.nodeSelector }} nodeSelector: {{- toYaml . | nindent 8 }} {{- end }} {{- with .Values.affinity }} affinity: {{- toYaml . | nindent 8 }} {{- end }} {{- with .Values.tolerations }} tolerations: {{- toYaml . | nindent 8 }} {{- end }}あらかじめ様々なパラメータが抽象化されています。開発者が編集するのは

spec.template.specの部分です。次のように変更します。deployment.yamlapiVersion: apps/v1 kind: Deployment metadata: name: {{ include "echo.fullname" . }} labels: app: {{ include "echo.name" . }} chart: {{ include "echo.chart" . }} release: {{ .Release.Name }} heritage: {{ .Release.Service }} spec: {{- if not .Values.autoscaling.enabled }} replicas: {{ .Values.replicaCount }} {{- end }} selector: matchLabels: {{- include "echo.selectorLabels" . | nindent 6 }} template: metadata: {{- with .Values.podAnnotations }} annotations: {{- toYaml . | nindent 8 }} {{- end }} labels: {{- include "echo.selectorLabels" . | nindent 8 }} spec: {{- with .Values.imagePullSecrets }} imagePullSecrets: {{- toYaml . | nindent 8 }} {{- end }} serviceAccountName: {{ include "echo.serviceAccountName" . }} securityContext: {{- toYaml .Values.podSecurityContext | nindent 8 }} containers: - name: nginx image: "{{ .Values.nginx.image.repository }}:{{ .Values.nginx.image.tag }}" imagePullPolicy: {{ .Values.nginx.image.pullPolicy }} ports: - name: http containerPort: 80 livenessProbe: httpGet: path: {{ .Values.nginx.healthCheck }} port: http readinessProbe: httpGet: path: {{ .Values.nginx.healthCheck }} port: http env: - name: BACKEND_HOST value: {{ .Values.nginx.backendHost | quote }} - name: echo image: "{{ .Values.echo.image.repository }}:{{ .Values.echo.image.tag }}" imagePullPolicy: {{ .Values.echo.image.pullPolicy }} ports: - containerPort: {{ .Values.echo.httpPort }} env: - name: HTTP_PORT value: {{ .Values.echo.httpPort | quote }} resources: {{- toYaml .Values.resources | nindent 12 }} {{- with .Values.nodeSelector }} nodeSelector: {{- toYaml . | nindent 8 }} {{- end }} {{- with .Values.affinity }} affinity: {{- toYaml . | nindent 8 }} {{- end }} {{- with .Values.tolerations }} tolerations: {{- toYaml . | nindent 8 }} {{- end }}パラメータは

values.yamlで指定します。生成されたvalues.yamlの中身は次のようになっています。values.yaml# Default values for echo. # This is a YAML-formatted file. # Declare variables to be passed into your templates. replicaCount: 1 image: repository: nginx pullPolicy: IfNotPresent # Overrides the image tag whose default is the chart appVersion. tag: "" imagePullSecrets: [] nameOverride: "" fullnameOverride: "" serviceAccount: # Specifies whether a service account should be created create: true # Annotations to add to the service account annotations: {} # The name of the service account to use. # If not set and create is true, a name is generated using the fullname template name: "" podAnnotations: {} podSecurityContext: {} # fsGroup: 2000 securityContext: {} # capabilities: # drop: # - ALL # readOnlyRootFilesystem: true # runAsNonRoot: true # runAsUser: 1000 service: type: ClusterIP port: 80 ingress: enabled: false annotations: {} # kubernetes.io/ingress.class: nginx # kubernetes.io/tls-acme: "true" hosts: - host: chart-example.local paths: [] tls: [] # - secretName: chart-example-tls # hosts: # - chart-example.local resources: {} # We usually recommend not to specify default resources and to leave this as a conscious # choice for the user. This also increases chances charts run on environments with little # resources, such as Minikube. If you do want to specify resources, uncomment the following # lines, adjust them as necessary, and remove the curly braces after 'resources:'. # limits: # cpu: 100m # memory: 128Mi # requests: # cpu: 100m # memory: 128Mi autoscaling: enabled: false minReplicas: 1 maxReplicas: 100 targetCPUUtilizationPercentage: 80 # targetMemoryUtilizationPercentage: 80 nodeSelector: {} tolerations: [] affinity: {}これを次のように書き換えます。

values.yamlreplicaCount: 1 nginx: image: repository: gihyodocker/nginx pullPolicy: Always tag: latest healthCheck: / backendHost: localhost:8080 echo: image: repository: gihyodocker/echo pullPolicy: Always tag: latest httpPort: 8080Serviceも同様に書き換えます。生成されたServiceの中身は次のようになっています。

service.yamlapiVersion: v1 kind: Service metadata: name: {{ include "echo.fullname" . }} labels: {{- include "echo.labels" . | nindent 4 }} spec: type: {{ .Values.service.type }} ports: - port: {{ .Values.service.port }} targetPort: http protocol: TCP name: http selector: {{- include "echo.selectorLabels" . | nindent 4 }}これを次のようにします。

service.yamlapiVersion: v1 kind: Service metadata: name: {{ include "echo.fullname" . }} labels: app: {{ include "echo.name" . }} chart: {{ include "echo.chart" . }} release: {{ .Release.Name }} heritage: {{ .Release.Service }} spec: type: {{ .Values.service.type }} ports: - port: {{ .Values.service.port }} targetPort: http protocol: TCP name: {{ .Values.service.name }} selector: {{- include "echo.selectorLabels" . | nindent 4 }}

values.yamlに次の設定を追記します。values.yamlservice: name: nginx type: ClusterIP port: 80次はIngressです。生成されたIngressの中身は次のようになっています。

ingress.yaml{{- if .Values.ingress.enabled -}} {{- $fullName := include "echo.fullname" . -}} {{- $svcPort := .Values.service.port -}} {{- if semverCompare ">=1.14-0" .Capabilities.KubeVersion.GitVersion -}} apiVersion: networking.k8s.io/v1beta1 {{- else -}} apiVersion: extensions/v1beta1 {{- end }} kind: Ingress metadata: name: {{ $fullName }} labels: {{- include "echo.labels" . | nindent 4 }} {{- with .Values.ingress.annotations }} annotations: {{- toYaml . | nindent 4 }} {{- end }} spec: {{- if .Values.ingress.tls }} tls: {{- range .Values.ingress.tls }} - hosts: {{- range .hosts }} - {{ . | quote }} {{- end }} secretName: {{ .secretName }} {{- end }} {{- end }} rules: {{- range .Values.ingress.hosts }} - host: {{ .host | quote }} http: paths: {{- range .paths }} - path: {{ . }} backend: serviceName: {{ $fullName }} servicePort: {{ $svcPort }} {{- end }} {{- end }} {{- end }}

metadata.labelsを書き換えます。ingress.yaml{{- if .Values.ingress.enabled -}} {{- $fullName := include "echo.fullname" . -}} {{- $svcPort := .Values.service.port -}} {{- if semverCompare ">=1.14-0" .Capabilities.KubeVersion.GitVersion -}} apiVersion: networking.k8s.io/v1beta1 {{- else -}} apiVersion: extensions/v1beta1 {{- end }} kind: Ingress metadata: name: {{ $fullName }} labels: app: {{ include "echo.name" . }} chart: {{ include "echo.chart" . }} release: {{ .Release.Name }} heritage: {{ .Release.Service }} {{- with .Values.ingress.annotations }} annotations: {{- toYaml . | nindent 4 }} {{- end }} spec: {{- if .Values.ingress.tls }} tls: {{- range .Values.ingress.tls }} - hosts: {{- range .hosts }} - {{ . | quote }} {{- end }} secretName: {{ .secretName }} {{- end }} {{- end }} rules: {{- range .Values.ingress.hosts }} - host: {{ .host | quote }} http: paths: {{- range .paths }} - path: {{ . }} backend: serviceName: {{ $fullName }} servicePort: {{ $svcPort }} {{- end }} {{- end }} {{- end }}

values.yamlに次の設定を追記します。これはvalues.yaml生成時のデフォルトの値です。values.yamlingress: enabled: false annotations: {} # kubernetes.io/ingress.class: nginx # kubernetes.io/tls-acme: "true" hosts: - host: chart-example.local paths: [] tls: [] # - secretName: chart-example-tls # hosts: # - chart-example.localまた、ServiceAccountは今回作成しないので、

serviceAccount.createはfalseとします。values.yamlserviceAccount: # Specifies whether a service account should be created create: false # Annotations to add to the service account annotations: {} # The name of the service account to use. # If not set and create is true, a name is generated using the fullname template name: ""

values.yaml全体は次のようになります。values.yamlreplicaCount: 1 nginx: image: repository: gihyodocker/nginx pullPolicy: Always tag: latest healthCheck: / backendHost: localhost:8080 echo: image: repository: gihyodocker/echo pullPolicy: Always tag: latest httpPort: 8080 imagePullSecrets: [] nameOverride: "" fullnameOverride: "" serviceAccount: # Specifies whether a service account should be created create: false # Annotations to add to the service account annotations: {} # The name of the service account to use. # If not set and create is true, a name is generated using the fullname template name: "" podAnnotations: {} podSecurityContext: {} # fsGroup: 2000 securityContext: {} # capabilities: # drop: # - ALL # readOnlyRootFilesystem: true # runAsNonRoot: true # runAsUser: 1000 service: name: nginx type: ClusterIP port: 80 ingress: enabled: false annotations: {} # kubernetes.io/ingress.class: nginx # kubernetes.io/tls-acme: "true" hosts: - host: chart-example.local paths: [] tls: [] # - secretName: chart-example-tls # hosts: # - chart-example.local resources: {} # We usually recommend not to specify default resources and to leave this as a conscious # choice for the user. This also increases chances charts run on environments with little # resources, such as Minikube. If you do want to specify resources, uncomment the following # lines, adjust them as necessary, and remove the curly braces after 'resources:'. # limits: # cpu: 100m # memory: 128Mi # requests: # cpu: 100m # memory: 128Mi autoscaling: enabled: false minReplicas: 1 maxReplicas: 100 targetCPUUtilizationPercentage: 80 # targetMemoryUtilizationPercentage: 80 nodeSelector: {} tolerations: [] affinity: {}

Chart.yamlにパッケージングに必要な情報を記載します。Chart.yamlapiVersion: v2 name: echo description: A Helm chart for Kubernetes type: application version: 0.1.0 appVersion: 0.1.0

helm lintで文法チェックができます。$ helm lint echo ==> Linting echo [INFO] Chart.yaml: icon is recommended 1 chart(s) linted, 0 chart(s) failedChartをインストールする

作成したChartをインストールします。

helm install --debug --dry-run リリース名 Chart名コマンドでインストールのdry runを実行できます。dry runでは生成されたマニフェストを確認することができます。$ helm install --debug --dry-run echo echo install.go:159: [debug] Original chart version: "" install.go:176: [debug] CHART PATH: /hogehoge/echo NAME: echo LAST DEPLOYED: Mon Jun 29 16:58:44 2020 NAMESPACE: default STATUS: pending-install REVISION: 1 USER-SUPPLIED VALUES: {} COMPUTED VALUES: affinity: {} autoscaling: enabled: false maxReplicas: 100 minReplicas: 1 targetCPUUtilizationPercentage: 80 echo: httpPort: 8080 image: pullPolicy: Always repository: gihyodocker/echo tag: latest fullnameOverride: "" imagePullSecrets: [] ingress: annotations: {} enabled: false hosts: - host: chart-example.local paths: [] tls: [] nameOverride: "" nginx: backendHost: localhost:8080 healthCheck: / image: pullPolicy: Always repository: gihyodocker/nginx tag: latest nodeSelector: {} podAnnotations: {} podSecurityContext: {} replicaCount: 1 resources: {} securityContext: {} service: name: nginx port: 80 type: ClusterIP serviceAccount: annotations: {} create: false name: "" tolerations: [] HOOKS: --- # Source: echo/templates/tests/test-connection.yaml apiVersion: v1 kind: Pod metadata: name: "echo-test-connection" labels: helm.sh/chart: echo-0.1.0 app.kubernetes.io/name: echo app.kubernetes.io/instance: echo app.kubernetes.io/version: "0.1.0" app.kubernetes.io/managed-by: Helm annotations: "helm.sh/hook": test-success spec: containers: - name: wget image: busybox command: ['wget'] args: ['echo:80'] restartPolicy: Never MANIFEST: --- # Source: echo/templates/service.yaml apiVersion: v1 kind: Service metadata: name: echo labels: app: echo chart: echo-0.1.0 release: echo heritage: Helm spec: type: ClusterIP ports: - port: 80 targetPort: http protocol: TCP name: nginx selector: app.kubernetes.io/name: echo app.kubernetes.io/instance: echo --- # Source: echo/templates/deployment.yaml apiVersion: apps/v1 kind: Deployment metadata: name: echo labels: app: echo chart: echo-0.1.0 release: echo heritage: Helm spec: replicas: 1 selector: matchLabels: app.kubernetes.io/name: echo app.kubernetes.io/instance: echo template: metadata: labels: app.kubernetes.io/name: echo app.kubernetes.io/instance: echo spec: serviceAccountName: default securityContext: {} containers: - name: nginx image: "gihyodocker/nginx:latest" imagePullPolicy: Always ports: - name: http containerPort: 80 livenessProbe: httpGet: path: / port: http readinessProbe: httpGet: path: / port: http env: - name: BACKEND_HOST value: "localhost:8080" - name: echo image: "gihyodocker/echo:latest" imagePullPolicy: Always ports: - containerPort: 8080 env: - name: HTTP_PORT value: "8080" resources: {} NOTES: 1. Get the application URL by running these commands: export POD_NAME=$(kubectl get pods --namespace default -l "app.kubernetes.io/name=echo,app.kubernetes.io/instance=echo" -o jsonpath="{.items[0].metadata.name}") echo "Visit http://127.0.0.1:8080 to use your application" kubectl --namespace default port-forward $POD_NAME 8080:80dry runでパラメータに問題ないか確認できたらインストールします。

$ helm install echo echo NAME: echo LAST DEPLOYED: Mon Jun 29 16:59:48 2020 NAMESPACE: default STATUS: deployed REVISION: 1 NOTES: 1. Get the application URL by running these commands: export POD_NAME=$(kubectl get pods --namespace default -l "app.kubernetes.io/name=echo,app.kubernetes.io/instance=echo" -o jsonpath="{.items[0].metadata.name}") echo "Visit http://127.0.0.1:8080 to use your application" kubectl --namespace default port-forward $POD_NAME 8080:80アプリが立ち上がっていることがわかります。

$ helm ls NAME NAMESPACE REVISION UPDATED STATUS CHART APP VERSION echo default 1 2020-06-29 16:59:48.534198 +0900 JST deployed echo-0.1.0 0.1.0 $ kubectl get deployment,service,ingress --selector app=echo NAME READY UP-TO-DATE AVAILABLE AGE deployment.apps/echo 1/1 1 1 2m10s NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/echo ClusterIP 10.111.40.236 <none> 80/TCP 2m10sIngressの使用がfalseになっていたので、これをtrueにして実行してみます。デプロイ済みのアプリは削除します。

$ helm uninstall echoローカルにはL7ロードバランサがないので、

NGINX Ingress Controllerを使用します。インストール方法はこちらを参照してください。$ kubectl apply -f https://raw.githubusercontent.com/kubernetes/ingress-nginx/master/deploy/static/provider/cloud/deploy.yaml $ kubectl -n ingress-nginx get service,pod NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/ingress-nginx-controller LoadBalancer 10.98.29.212 localhost 80:32012/TCP,443:30306/TCP 3m46s service/ingress-nginx-controller-admission ClusterIP 10.107.104.62 <none> 443/TCP 3m46s NAME READY STATUS RESTARTS AGE pod/ingress-nginx-admission-create-6plnl 0/1 Completed 0 3m36s pod/ingress-nginx-admission-patch-csb5s 0/1 Completed 0 3m36s pod/ingress-nginx-controller-579fddb54f-d47d7 1/1 Running 0次に、カスタムValueファイルを作成します。

$ vi echo.yaml ingress: enabled: true hosts: - host: "ch06-echo.gihyo.local" paths: ["/"]カスタムValueファイルを使用してアプリをインストールします。

$ helm install -f echo.yaml echo echo NAME: echo LAST DEPLOYED: Mon Jun 29 17:32:19 2020 NAMESPACE: default STATUS: deployed REVISION: 1 NOTES: 1. Get the application URL by running these commands: http://ch06-echo.gihyo.local/

curlでアクセスしてみます。$ curl http://localhost -H 'Host:ch06-echo.gihyo.local' Hello Docker!!これで成功です!

パッケージをつくる

helm packageコマンドでパッケージングできます。$ helm package echo $ ls echo/ echo-0.1.0.tgz echo.yamlおわりに

今回は「Docker/Kubernetes 実践コンテナ開発入門」をHelm v3で行いました。コンテナまわりの技術は進歩が速くて追いかけるのが大変です。

- 投稿日:2020-06-30T23:22:27+09:00

React.jsをDockerで動かした時のメモ

環境

$ cat /etc/linuxmint/info RELEASE=19.3 CODENAME=tricia EDITION="Cinnamon" DESCRIPTION="Linux Mint 19.3 Tricia" DESKTOP=Gnome TOOLKIT=GTK NEW_FEATURES_URL=https://www.linuxmint.com/rel_tricia_cinnamon_whatsnew.php RELEASE_NOTES_URL=https://www.linuxmint.com/rel_tricia_cinnamon.php USER_GUIDE_URL=https://www.linuxmint.com/documentation.php GRUB_TITLE=Linux Mint 19.3 CinnamonDockerのインストール

$ apt update $ apt install docker-ce docker-ce-cli docker-composenode.jsとcreate-react-appのインストール

$ apt install nodejs $ npm install create-react-app yarnサンプルReact.jsアプリを作る

$ create-react-app docker-test $ cd docker-testとりあえず普通に起動してみる。

yarn startブラウザで http://localhost:3000 にアクセスしReact.jsが動作していることを確認。

確認できたらCtrl-Cで落とす。Dockerfileとdocker-compose.ymlを作成

作成したReactアプリのルートディレクトリに以下のような内容で

Dockerfileとdocker-compose.ymlを作る。DockerfileFROM node:14.4.0-buster-slim WORKDIR /usr/src/app RUN npm install --save prop-types RUN npm install -g create-react-appdocker-composeversion: '3' services: node: build: context: . tty: true environment: - NODE_ENV=production volumes: - ./:/usr/src/app command: sh -c "yarn start" ports: - "3000:3000"上記のような内容だと、作成したReactアプリのルートディレクトリがDocker環境内では

/usr/src/appにマウントされるため、 WORKDIRを/usr/src/appに指定してあれば、実行するスクリプトはsh -c "yarn start"だけとなるため、これをcommandで指定している。docker-hub nodeを見に行くと、

alpinebusterstretchなどの名前がバージョンについています。なんのことかと思ったらLinuxディストリビューションですね。

slimとついているものは、Debianディストリビューションでエクストラパッケージが含まれないものです。いずれにしても今回はDockerでnodeが動けばいいのでnode:14.4.0-buster-slimを選択しました。

ちなみにDebianの現在のバージョンは buster(10.0) であり、それ以前は以下のようになります。Debian 10 (buster) — 現在の安定版リリース Debian 9 (stretch) — 過去の安定版リリース Debian 8 (jessie) — 過去の安定版リリース Debian 7 (wheezy) — 過去の安定版リリースalpine linuxはパワーユーザー向けの軽量Linuxのようです。軽量だけにイメージが小さく抑えられるかもしれませんが、私はDebianやUbuntuしか使ったこと無いので

alpineの使用はやめておきました。Dockerイメージをビルド

$ docker-compose buildDockerでReact.jsアプリを実行する

起動

$ docker-compose upブラウザで http://localhost:3000 にアクセスしReact.jsが動作していることを確認。

Ctrl-Cで停止。バックグラウンドで起動

$ docker-compose up -d停止

$ docker-compose downイメージ情報を確認

$ docker images | grep dockertest dockertest_node latest daf22d9465c7 26 minutes ago 194MBおまけ

すべてのDockerイメージを停止

$ docker stop $(docker ps -q)

- 投稿日:2020-06-30T21:25:29+09:00

ラズパイに向けてRustをクロスコンパイル!

想定読者

- Rustが好きだ!Rustが使いたいんだ!でも、ラズパイに向けたクロスコンパイル方法がわからない!

- クロスコンパイルのやり方は知らなくても、どんなのかは知っている

- Dockerにアレルギー反応を起こさない

- アーキテクチャの名前にアナフィラキシー・ショックを起こさない

- ツールチェイン、リンカという言葉に拒絶反応を起こさない

という人向けの、初心者による初心者のための記事です。

(というか私の備忘録です。)環境

開発環境

OS:Ubuntu 20.04 LTS

アーキテクチャ:x86_64実行環境

ハードウェア:RaspberryPi4 typeB 4GB

OS:Raspbian(Version: May 2020)

アーキテクチャ:ARMv7目標

rust-pushordを用いたRust製GUIアプリケーションをRaspberryPi用にクロスコンパイルして、Raspbian上でも動かすこと。

流れ

- rustの公式Dockerイメージを使って開発環境を整える

- コンテナ内に「Hello World」を用意する。

- CargoへARMv7向けにコンパイルするように設定する

- ツールチェインとリンカを用意する

- コンパイルの確認

- rust-pushordの依存ライブラリを用意する(SDL2)

- rust-pushordのexampleをコンパイルする

- RaspberryPi上で実行する

- 喜びの舞を踊る(option)

1. rustの公式Dockerイメージを使って開発環境を整える

Dockerのインストール等は割愛させていただきます。

インストールが終わったら早速、Rustの公式イメージゲットだぜ!

bashdocker container run -v ホスト:コンテナ -it --rm rust:latest /bin/bash(注:もしかしたらsudoがいるかもね。)

将来的なことを考えるとDockerfileを用意したほうがいい気がするけど、ここでは「初心者による初心者のための」ということで作りません。

2. コンテナ内に「Hello World」を用意する。

初めに、コンテナ内で「Hello World」のコードを作り、確認のため普通(開発環境アーキテクチャ向け)に実行します。

bashroot@abcd12345:/# export USER=root root@abcd12345:~# cd root@abcd12345:~# cargo new hello root@abcd12345:~# cd hello root@abcd12345:~/hello# cargo runこれで「Hello World」が帰ってきたらOK。

3. CargoへARMv7向けにコンパイルするように設定する

次に「.cargo/config」を作成しクロスコンパイルをするための設定を記述します。

bashroot@abcd12345:~/hello# mkdir .cargo root@abcd12345:~/hello# cat <<EOF > .cargo/config [target.armv7-unknown-linux-gnueabihf] linker = "arm-linux-gnueabihf-gcc" EOFこれは

「cargoでtargetにarmv7-unknown-linux-gnueabihfが指定されたら、リンカにarm-linux-gnueabihf-gccを使ってね!」

とcargoにお願いするためのものです。4. ツールチェインとリンカを用意する

さて、次に用意しないと行けないのが「ARMv7用の、ツールチェインとリンカ」です。

bash# ツールチェインの追加 rustup target add armv7-unknown-linux-gnueabihf # 備考:用意されているツールチェインは次のコマンドで表示できます # rustup target list # リンカの用意 apt install gcc-arm-linux-gnueabihf5. コンパイルの確認

さぁ、準備ができたので、コンパイルがちゃんと通るか確かめて見ましょう!

bashroot@abcd12345:~/hello# cargo build --target=armv7-unknown-linux-gnueabihf実際にARMv7上で動くかは、RaspbianのDockerイメージを使ってみたり、実機でテストしてください。

6. rust-pushordの依存ライブラリを用意する(SDL2)

CUIだと寂しいのでGUIアプリをコンパイルしてみましょう!

クロスプラットフォームでさくっとできるのにrust-pushordというのがあるので、これを使います。

任意の場所にGitHubからクローンして、exampleをコンパイルしましょう。

bashroot@abcd12345:~# git clone https://github.com/KenSuenobu/rust-pushrod.git root@abcd12345:~# cd rust-pushrod root@abcd12345:~/rust-pushrod# cargo build --target=armv7-unknown-linux-gnueabihf --example timer残念なことに、失敗しますね。。かなしみ。

... "-ldl" "-lutil" = note: /usr/lib/gcc-cross/arm-linux-gnueabihf/8/../../../../arm-linux-gnueabihf/bin/ld: cannot find -lSDL2 /usr/lib/gcc-cross/arm-linux-gnueabihf/8/../../../../arm-linux-gnueabihf/bin/ld: cannot find -lSDL2_image /usr/lib/gcc-cross/arm-linux-gnueabihf/8/../../../../arm-linux-gnueabihf/bin/ld: cannot find -lSDL2_ttf collect2: error: ld returned 1 exit status error: aborting due to previous error error: could not compile `rust-pushrod`. To learn more, run the command again with --verbose.どうやらrust-pushordに必要なSDL2が足りていないようです。

では「依存関係を解決するためにapt install libsdl2-devすればいいのか」というと、そうは問屋がおろしません。

なぜなら、必要としているSDL2は「ARMv7向け」だからです。

ということで、次のようにしないといけません。

bash# マルチアーキテクチャでarmhfを有効にする dpkg --add-architecture armhf # 本当は、armhf向けのパッケージが必要とする必須の # 基本的なarmhf向けのアプリをインストールする必要があります。 # しかし、Rustの公式Dockerイメージには、もうすでに入ってるのでスキップします。 # apt install crossbuild-essential-armhf # 必要なSDL2のライブラリをインストール apt install libsdl2-dev:armhf libsdl2-image-dev:armhf libsdl2-ttf-dev:armhfこれで依存ライブラリも揃いました。もう一度コンパイルして、うまく行くことを確認してみてください。

bashroot@abcd12345:~/rust-pushrod# cargo build --target=armv7-unknown-linux-gnueabihf --example timer8. RaspberryPi上で実行する

コンパイルしてできたものを共有フォルダに移し、ホスト側に取り出し、RaspberryPiに持っていってください。

そして実行ししっかりと動くか確認してみましょう。

ついに、RustがRaspberryPi上で動くはずです。(画像は明日くらいに載せます。(現在:2020/6/30))

9. 喜びの舞を踊る(option)

♪(((^-^)八(^∇^)))♪

お疲れ様でした。今回、私自身が「Rustで組み込み!初クロスコンパイル!」ということで、情報を漁るも、簡単には見つからなかったため、記事にさせていただきました。(特にライブラリの依存関係を解消するあたり)

誰かの参考になれば幸いです。

- 投稿日:2020-06-30T21:23:33+09:00

Dockerの不要コンテナを一括削除する

最近AWSのEC2(AmazonLinux2)上でDockerを入れて色々と

遊んで勉強しているのですが、

centosのコンテナを作成する → ごにょごにょする → 終わる、mysqlのコンテナを作る → ごにょごにょする → 終わるなどを繰り返し行い、たまにdocker psコマンドでコンテナの稼働状況を確認してたんですが、ある時docker ps -aを実行したところなんじゃこりゃぁ!!となりました。

そこで「Dockerコンテナは終わっても、Dockerの事は嫌いにならないでください!」と

◯田敦子さんが言ったかどうかは定かではないですが、少なくともDockerコンテナは終わってもDockerコンテナは残っているという事を学んだわけです。無駄な前置きが長くなりましたが、この溜まりに溜まったゴミDockerコンテナを削除するための

コマンドの覚書です。awkを利用した不要コンテナの削除

削除前の状態

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 9ec50bb2ac79 mysql "docker-entrypoint.s…" 4 days ago Up 2 days 3306/tcp, 33060/tcp MYSQL 20cabc9db638 centos "/bin/bash" 4 days ago Up 2 days 0.0.0.0:9989->8080/tcp centos_container 149e47fc7182 mysql "docker-entrypoint.s…" 4 days ago Exited (0) 4 days ago silly_haibt 6d0b42666db1 mysql "docker-entrypoint.s…" 4 days ago Exited (0) 4 days ago stoic_panini cc75432e283b mysql "docker-entrypoint.s…" 4 days ago Exited (127) 4 days ago serene_merkle e75ea014088a mysql "docker-entrypoint.s…" 4 days ago Exited (0) 4 days ago laughing_allen 7f6d0144717d centos "/bin/bash" 4 days ago Exited (0) 4 days ago zealous_haibt b78d2f0c9b93 centos "/bin/bash" 4 days ago Exited (0) 4 days ago centos_1 a1adb31a4719 mysql "docker-entrypoint.s…" 4 days ago Exited (0) 4 days ago mysql_container b977c75c9dd7 mysql "docker-entrypoint.s…" 4 days ago Exited (1) 4 days ago bold_nobel 6c590752cab8 mysql "docker-entrypoint.s…" 4 days ago Exited (1) 4 days ago gifted_nightingale上記のうち、稼働中の上2つ以外を削除する。

※今回はdocker ps -f status=<ステータス>で"Exited"のコンテナのみを削除docker ps -f status=exited | awk '{print $1}' | xargs docker rm実行結果

149e47fc7182 6d0b42666db1 cc75432e283b e75ea014088a 7f6d0144717d b78d2f0c9b93 a1adb31a4719 b977c75c9dd7 6c590752cab8 Error: No such container: CONTAINER[ ~]$ docker ps -a CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 9ec50bb2ac79 mysql "docker-entrypoint.s…" 4 days ago Up 2 days 3306/tcp, 33060/tcp MYSQL 20cabc9db638 centos "/bin/bash" 4 days ago Up 2 days 0.0.0.0:9989->8080/tcp centos_container無事不要なコンテナは消えましたが、ヘッダー行の"CONTAINER"で

docker rmをしようとしてエラーとなってますね。。(ま、いっか)Docker公式ドキュメント方式(-_-) ※こちらおすすめしております!

上記コマンド作成後、Docker公式マニュアルに稼働していないコンテナ削除方法が載ってました。。

上のしょーもないawk方式なんかより先に載せろよと言われるかもしれませんが...実行前状態(もう一度不要なコンテナを増産しました)

docker ps -a CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 109839ada027 centos "/bin/bash" 35 seconds ago Exited (0) 34 seconds ago vibrant_bohr cf2e8c41b2ee centos "/bin/bash" 36 seconds ago Exited (0) 36 seconds ago brave_mestorf fcfdaf35235d centos "/bin/bash" 37 seconds ago Exited (0) 37 seconds ago gallant_faraday bf7b9fa96291 centos "/bin/bash" 38 seconds ago Exited (0) 38 seconds ago zealous_morse 9ec50bb2ac79 mysql "docker-entrypoint.s…" 4 days ago Up 2 days 3306/tcp, 33060/tcp MYSQL 20cabc9db638 centos "/bin/bash" 4 days ago Up 2 days 0.0.0.0:9989->8080/tcp centos_container削除コマンド

コマンド説明(公式マニュアルより)

このコマンドは停止しているコンテナを全て削除します。コマンド docker ps -a -q は終了した全てのコンテナ ID を rm コマンドに渡し、全て削除するものです。実行中のコンテナは削除されません。

docker rm $(docker ps -a -q)実行結果

109839ada027 cf2e8c41b2ee fcfdaf35235d bf7b9fa96291 Error response from daemon: You cannot remove a running container 9ec50bb2ac797f3cfdbe827aa2793ba135f6f29e9fd2c1b179afa09d6be4b5ba. Stop the container before attempting removal or force remove Error response from daemon: You cannot remove a running container 20cabc9db6380304c3c0c3b8a14f04e0bd60fd58c810ee4c02d6539fd5b4f3f3. Stop the container before attempting removal or force remove実行中のコンテナは削除しようとしてエラーとなります。

試してはいませんが、docker rm -f $(docker ps -a -q)とするとコンテナ皆殺しの刑に処す!

となるはずですし、ここまで読んだ殆どの方はお気づきかと思いますが、上記awk方式で実施した

内容も下記コマンドで実現できます...docker rm $(docker ps -f status=exited -q)それでは、お後がよろしいようで。。。テケテン

- 投稿日:2020-06-30T20:27:10+09:00

EC2(AmazonLinux2)にJenkinsを構築する

EC2 に Jenkins を構築したのでその作業のメモです。

鍵に権限を付与します。

$ chmod 600 KEY_NAME.pemログインします。

$ ssh -i KEY_NAME.pem ec2-user@{IP_ADDRES}アップデートします。

$ sudo su - $ yum -y update $ yum -y upgradeNginx をインストールします。(必要な場合)

$ amazon-linux-extras install nginx1.12 $ yum -y install nginx $ systemctl enable nginx.service $ systemctl start nginx.service $ systemctl status nginx.serviceDocker をインストールします。

$ yum -y install docker $ systemctl enable docker.service $ systemctl start docker.serviceマウントするディレクトリを作成します。

$ mkdir /home/jenkins_home $ chown -R 1000:1000 /home/jenkins_homeJenkins を起動します。

docker run \ --name jenkins \ --detach \ --volume /home/jenkins_home:/var/jenkins_home \ --publish 8080:8080 \ --publish 50000:50000 \ jenkins/jenkins:ltsNginx の設定を追加します。(必要な場合)

nginx.confuser root; worker_processes 4; events { worker_connections 1024; } http { include mime.types; default_type application/octet-stream; sendfile on; keepalive_timeout 65; include /etc/nginx/conf.d/*.conf; }jenkins.confserver { listen 80 default_server; listen [::]:80 default_server; server_name _; location / { proxy_set_header Host $http_host; proxy_pass http://localhost:8080; } }Nginxを再起動します。

$ systemctl restart nginx.service参考

- 投稿日:2020-06-30T19:43:43+09:00

Dockerでローカル開発環境のhttps化

はじめに

ローカル開発環境の https 化

https://blog.jxck.io/entries/2020-06-29/https-for-localhost.html

この記事を読ませて頂き、自分の環境ではこうやってるよというのをシェアしようと思いました。

Let's Encryptによる証明書ではなくて、自己署名証明書を使う方法になります。

また、記事で指摘されているlocalhostの特殊性を無視して粗があっても手早くhttpsで開発したい人向けですhttps化の動機

localhostとの通信を暗号化しても無意味な気がしますが、そうせざるをえない時もあります

- mixed contentでリソースがブロックされる

- FacebookのOAuthで設定するredirect URIはhttpsでないと動かない

- Geolocation APIで位置情報を取得する時にhttpsでないと動かない

そのような時のためにlocalhostをhttpsで使う手順があると便利です。

ngrokなどもありますが、手元で完結するタイプの方法になります。steps

https-portalimageを使うこちらのイメージを使わせて頂きます。

https://github.com/SteveLTN/https-portaldocker-compose.ymlversion: "3" services: https-portal3000: image: steveltn/https-portal:1 ports: - '3443:443' environment: STAGE: local DOMAINS: 'localhost -> http://host.docker.internal:3000'このコンテナは、

https://localhost:3443でリクエストを受けてhttp://localhost:3000にフォワーディングしてくれる設定となります。

(localhost:3000で開発中のアプリケーションが動いていることを想定)

STAGE=localこの環境変数を渡すとコンテナの中で自己署名証明書を作ってくれます(便利!)

Docker Desktop for Macを使っている場合はこれでOK。他の環境ではextra_hostsの設定が必要でしょう。

例:docker-compose.ymlversion: "3" services: https-portal3000: image: steveltn/https-portal:1 ports: - '3443:443' environment: STAGE: local DOMAINS: 'localhost -> http://host.docker.internal:3000' extra_hosts: - "host.docker.internal:172.17.0.1"Dockerでアプリケーションを動かしている場合は

host.docker.internalでなくて直接コンテナに繋いでも動くと思います。Chromeで警告を無視する

これをEnabledにすると localhost に限り自己署名証明書であっても警告が出なくなります。

chrome://flags/#allow-insecure-localhostセキュリティを下げる設定ですが対象がlocalhostのみなので許容します。

以上で https://localhost:3443/ へhttpsアクセスできます。

- 投稿日:2020-06-30T17:43:08+09:00

cx_Oracle が使える Docker イメージ

Python アプリから Oracle データベースに繋ぐ必要があり Python クライアントを入れる Dockerfile を書いたのだが、やたら苦労したので備忘録として書いておく。

DockerfileFROM python:3.7 RUN pip install cx_Oracle # Install Oracle Client ENV ORACLE_HOME=/opt/oracle ENV LD_LIBRARY_PATH=$LD_LIBRARY_PATH:$ORACLE_HOME/lib RUN apt-get update && apt-get install -y libaio1 && rm -rf /var/lib/apt/lists/* \ && wget -q https://download.oracle.com/otn_software/linux/instantclient/19600/instantclient-basic-linux.x64-19.6.0.0.0dbru.zip \ && unzip instantclient-*.zip \ && mkdir -p $ORACLE_HOME \ && mv instantclient_19_6 $ORACLE_HOME/lib \ && rm -f instantclient-*.zipcx_Oracle 8 Initialization — cx_Oracle 8.0.0 documentation

公式ドキュメントによると、cx_Oracle を利用するためには Oracle Client ライブラリがインストールされている必要があり、cx_Oracle は次の順序でライブラリの読み込みを試行する。

cx_Oracle.init_oracle_client(lib_dir="...")で指定したパス- OS のライブラリパス (

$LD_LIBRARY_PATH)$ORACLE_HOME/libこのうち

1.と3.の方法で試したときに、他のライブラリは読み込めるのにlibnnz19.soだけ「そんなファイルは無い」などとエラーが出て大変困った。

原因はいまだにわからない。

2.の方法を試したところ問題なく読み込まれた。

- 投稿日:2020-06-30T15:23:52+09:00

Dockerで作ったDjangoアプリケーションをHerokuにデプロイする

はじめに

Container Registryを使ってHerokuにデプロイする記事が、Railsが多い一方でDjangoではそんなにヒットしなかったので、アウトプットがてら書いていきます。まだ勉強中の身なので、もし間違えていたら指摘お願いします。

Heroku CLIをダウンロード

始めにこのリンクからHeroku CLIをダウンロードします。僕はwindows 10を使っているので、64ビットインストーラを使ってダウンロードしました。

他のOSを使っている人でも、やり方は詳しく(英語で)書かれているので、その通りにダウンロードしてください。Heroku上でアプリを作成、アドオン等設定

Herokuにログインしてアプリを作成し、OverviewのところからHeroku PostgresをAdd-onsとして設定します。このとき、Hobby Devを選択することで無料で使えるっぽい。(ただし遅いとかなんとか…)

Herokuではvolumeが使えないため、データの永続化をするためにこのようにDBを利用しています。requirement.txtに追記

requirement.txtgunicorn dj-database-urlsetting.pyに追記

以下のようにsetting.pyの下の方にstatic_rootとデータベースの設定を書いていきます。

STATIC_ROOTを設定することで本番環境でも静的ファイルを扱えるようになります。setting.pyDEBUG = False ALLOWED_HOSTS = ['自分のドメイン'] (略) STATIC_ROOT = os.path.join(BASE_DIR, 'staticfiles') (略) import dj_database_url DATABASES['default'] = dj_database_url.config(conn_max_age=600, ssl_require=True)Procfileを用意

Dockerfileと同じディレクトリにProcfileという名前のファイルを準備し、以下のように記述します。

Procfileweb: gunicorn [プロジェクト名].wsgiプロジェクト名はご自身のプロジェクト名に置き換えてください。

Dockerfileに追記

以下のようにDockerfileの一番下に追記します。

DockerfileCMD gunicorn --bind 0.0.0.0:$PORT [プロジェクト名].wsgiこちらも同様にプロジェクト名を置き換えてください。

コマンドを実行

プロジェクトがあるディレクトリ上でコマンドを実行していきます。

$ heroku login $ heroku container:login $ heroku container:push web -a [アプリ名] $ heroku container:release web -a [アプリ名] $ heroku open -a [アプリ名]No webprocess runningエラーが出たら以下のコマンドを実行しましょう。

$ heroku ps:scale web=1 -a [アプリ名]コンテナとHeroku Postgresを結び付ける

$ heroku addons:attach [postgresコンテナ名] -a [アプリ名]postgresコンテナ名はHerokuのアプリ管理サイトのOverviewのInstalled add-onsから確認することができます。また、最初以外にもマイグレーションが失敗するときなどにこのコマンドを再度実行し、再び結び付け直すことで上手くいくようになることがあります。

マイグレーションの実行

以下のコマンドでマイグレーションを実行します。

$ heroku run python manage.py migrate -a [アプリ名]collectstaticの実行

collectstaticを実行します。whitenoiseを使うとここら辺が省略できるらしい…?

$ heroku run python manage.py collectstatic -a [アプリ名]おわりに

とりあえずDockerを利用してデプロイは出来たものの、なぜかdjango-herokuを使うと500エラーが出たり、静的ファイルが適用出来ていなかったりするので、もうちょっと触りながら勉強します。

- 投稿日:2020-06-30T14:53:39+09:00

Goの実行環境をDockerで構築しようと際に発生した「no Go files in /go/src/github.com/go-playground/localesエラー」を解決

はじめに

root@xxxxxxxxxxxx:/go# go get github.com/go-playground/localesいつものようにパッケージをインストールしていたら次のエラーが発生。

can't load package: package github.com/go-playground/locales: no Go files in /go/src/github.com/go-playground/localesここのlocalesフォルダの中に何もファイルなんてねーよ!って言われてるんですね。そんなこと言われても。。。

解決方法

go getをしても同じエラーが吐かれるだけだったので、試しにlocalesフォルダを削除して、再度以下コマンドを叩いてみました。

root@xxxxxxxxxxxx:/go# go get github.com/go-playground/localesすると2分程度でパッケージのインストールが終わりました。

入った!

無事コンパイルが終了し、GoをDocker環境で構築することができました。Docker便利です。

- 投稿日:2020-06-30T14:25:28+09:00

Docker基本コマンド

はじめに

Dockerについての記事は沢山ありますが

自分用の忘備録です。

覚えたコマンドは随時追加コンテナの起動/再起動

docker start [コンテナ識別子]コンテナの停止

docker stop [コンテナ識別子]コンテナの削除

docker rm [コンテナ識別子]コンテナを作って中に入る

docker run -it [イメージ名] bin/shコンテナの名前を変えるコマンド

docker rename [古いコンテナ名][新しいコンテナ名]Docker-compose build

docker-compose buildimageを作成・Pullするコマンド

docker-compose run

docker-compose run (サービス名) (コマンド) example: docker-compose run --rm app bashコンテナを起動して、コマンドを実行することができる。

-rm を追加することによって、コマンドを実行した後に、

コンテナを削除します。docker-compose up する前などに、一時的にコンテナ内に入り

コマンドを実行したい時などに便利です。docker-compose exec

docker-compose exec (サービス名) (コマンド名) example: docker-compose exec app bashこれは、稼働中のコンテナに入りコマンドを実行するための物です。

docker-compose run

docker-compose upこのコマンドを実行すると、

docker-compose.ymlで記述した通りにコンテナを作成し、

コンテナ同士を繋げて起動をします。-d をオプションとしてつけることで、バックグラウンドでコンテナを起動します。

- 投稿日:2020-06-30T10:48:19+09:00

GithubActionsでのDocker BuildでCacheを効かせる方法メモ

はじめに

GithubActionsでDockerのコンテナをBuildするとデフォルトだとLayerのCache?がされないため、毎回Dockerfileの先頭から実行することになります(何も工夫をしないと)。

「LocalでBuildするときは(Cacheが効いて)速いんだけど、GithubActionsだと遅い」というのは、Buildに時間がかかる場合結構しんどいです(Twitterなどが捗ってしまう)。色々方法があるようですが、Dockerのマルチステージビルドを使っていないなら、割と簡単にCacheを効かせられるようなので、そのメモです(主に自分用)。

Docker BuildでCacheを効かせる方法

ポイントは docker buildコマンドの

--cache-fromと--build-arg BUILDKIT_INLINE_CACHE=1になります。また、このOptionを指定するには、BuildKitを有効にしないといけないので、環境変数DOCKER_BUILDKIT=1を指定しておくことが必要になります(buildx でも良いようですが)。上記リンクのドキュメントにも書いてありますが、それぞれ次のような意味になります。

--cache-from: CacheSourceを指定するコマンドで、外部リポジトリを指定すると適宜アクセスしてくれるようです。--build-arg BUILDKIT_INLINE_CACHE=1: Build時にMeta情報を埋め込み、--cache-fromで使えるようにします。これをリポジトリにPushしておけば、前回Build時のLayerを再利用できるようになります。- 環境変数

DOCKER_BUILDKIT=1: こう設定しておくとBuildKitが有効になるようです。GithubActionsでも使えるようです。サンプル

例えば、AWSのECRにPushする場合は、以下のように書くことができます。

aws.ymlon: push: tags: release-* # トリガーは `release-****` というTagがPushされたとき name: Push to Amazon ECR jobs: push: name: BuildAndPush runs-on: ubuntu-latest steps: - name: Checkout uses: actions/checkout@v2 - name: Configure AWS credentials uses: aws-actions/configure-aws-credentials@v1 with: aws-access-key-id: ${{ secrets.AWS_ACCESS_KEY_ID }} aws-secret-access-key: ${{ secrets.AWS_SECRET_ACCESS_KEY }} aws-region: ap-northeast-1 - name: Login to Amazon ECR id: login-ecr uses: aws-actions/amazon-ecr-login@v1 - name: Build, tag, and push image to Amazon ECR id: build-image env: DOCKER_BUILDKIT: 1 # これ大事 ECR_REGISTRY: 999999999999.dkr.ecr.ap-northeast-1.amazonaws.com # TODO: 要変更 ECR_REPOSITORY: my-awesome-container # TODO: 要変更 IMAGE_TAG: ${{ github.sha }} run: | # latest と github.sha でタグをふる場合 docker build \ --cache-from=$ECR_REGISTRY/$ECR_REPOSITORY:latest --build-arg BUILDKIT_INLINE_CACHE=1 \ -t $ECR_REGISTRY/$ECR_REPOSITORY:$IMAGE_TAG -t $ECR_REGISTRY/$ECR_REPOSITORY:latest . docker push $ECR_REGISTRY/$ECR_REPOSITORY:$IMAGE_TAG docker push $ECR_REGISTRY/$ECR_REPOSITORY:latest echo "::set-output name=image::$ECR_REGISTRY/$ECR_REPOSITORY:$IMAGE_TAG"さいごに

actions/cache@v2とか使うともっと良い(速い)のかもしれないですが、使わなくてもできるんだな、と思ったのでメモしておきます。

- 投稿日:2020-06-30T09:10:31+09:00

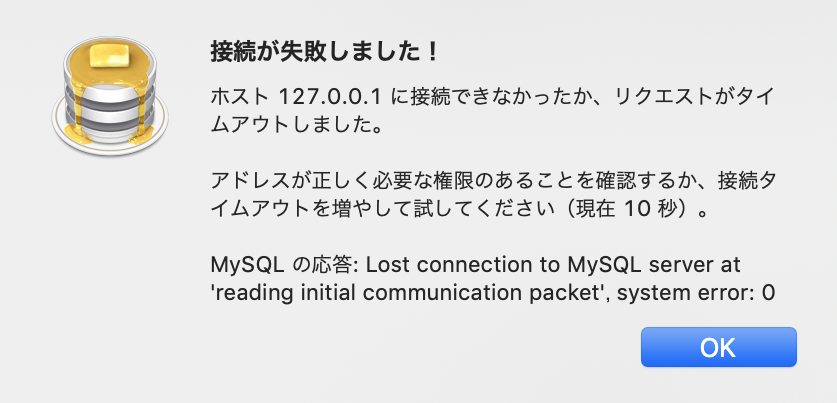

[mysql,docker,ESET]Lost connection to MySQL server at 'reading initial communication packet', system error: 0の解決例

どんなエラー?

接続者がデータベースに対して権限を持っていない状態で接続を試みると出るエラーのようです

何をしたら出た?

docker-compose upで予め用意したdocker-compose.ymlに沿って正しく立ち上げで、ローカルでの接続で権限をいじった記憶もないのに出現しました試行錯誤

この記事を見て関係ありそうな部分をすべて試すも空振りしました。

原因

会社のPCということもありセキュリティに厳しくしているようで

ESET Endpoint SecurityというファイアウォールをMacのデフォルト以外に取り入れており、そのセキュリティが、データベースへの直接の接続はローカルであっても妨げているようでした。(それだけ保存されたデータは取り扱い注意であるのだとわかりますね。)解決方法

ESETのパーソナルファイアーウォールをオフにすることで接続が可能になります

(手順は、画面左にある

保護の状態をクリック→画面中央にあるパーソナルファイアーウォールをクリック→画面中央のパーソナルファイアーウォールのオンオフスイッチをクリックしてオフにする)いくら取り扱い注意とはいえ、ローカルでSQL文の挙動の実験などをする必要がある場合がありますので、必要に応じて操作できる・できないの状態を変更できる方法を覚えておけるといいと思います。

- 投稿日:2020-06-30T08:52:56+09:00

docker-composeでNode.js(Express)とPostgresSQLを連携したサービスを作る勉強会

概要

先日行われた勉強会にて簡易ではありますが表題のサービスを作りました。Dockerの勉強の延長で取り組みました。この記事ではそのときの勉強会の内容を記載します。

どんなモノをつくるのか?

- チャットのようなアプリケーション

- docker-composeによるデータベースとの連携

- Node.js(Express)でフロントエンド&バックエンド

- データベースはPostgresSQL

完成したソースコード

https://gitlab.com/tamoco-mocomoco/study-docker-compose

参考にさせていただいた記事

https://qiita.com/ryo-ohnishi/items/b54e649b14b51694ef77

作ったモノの説明

docker-compose

サービス:app

app: build: context: ./ # Dockerfile保存場所 depends_on: - database image: n-app # イメージ名 container_name: n-app # コンテナ名 ports: # ポート接続 - 3000:5000 environment: PORT: 5000 DB_USER: postgres DB_HOST: database DB_PORT: 5432 DB_NAME: test_db

appはNode.js(Express)がメインとなるサービスになります。ここでは学習のために敢えてデフォルトのポートを5000に変更しています。これは参考にさせていただいたExpressの環境変数でPORTが使用されており、それをdocker-composeで5000に上書きしています。コンテナ内の5000をホスト側の3000に転送しています。ちなみにExpressで環境変数が使用されている箇所はapp/bin/のwwwというファイルで確認できます。app/bin/www

#!/usr/bin/env node /** * Module dependencies. */ var app = require('../app'); var debug = require('debug')('myapp:server'); var http = require('http'); /** * Get port from environment and store in Express. */ var port = normalizePort(process.env.PORT || '3000'); app.set('port', port); ~以下省略~サービス:database

database: image: postgres:12.3 volumes: - ./init-sql:/docker-entrypoint-initdb.d:ro environment: POSTGRES_DB: test_db TZ: "Asia/Tokyo" POSTGRES_HOST_AUTH_METHOD: trust

databaseはPostgresSQLを使用しています。docker-composeで環境変数であるPOSTGRES_DBをtest_dbに設定することで自動的にtest_dbという名前のデータベースが作成されます。

volumesの設定はinit-dbというフォルダにSQLファイルを格納しておくことで、SQLファイルに書かれているクエリを自動的に実行してくれます。

初期スキーマの設定(テーブル構造の作成)やダミーデータなどを挿入するときに利用します。実行順序はファイル名の昇順で実行されるので、ファイル名に番号などをつけるとよさそうです。

今回、作成したデータベースには

postgresというユーザーが作成されますが、パスワードが設定されていません。そのためPOSTGRES_HOST_AUTH_METHODをtrustに設定する必要があります。あと、

TZでタイムゾーンを設定しています。タイムゾーンの変更については以下のクエリでも可能です。ALTER DATABASE test_db SET timezone TO 'Asia/Tokyo'; SELECT pg_reload_conf();

init-dbにクエリをファイルとして格納しておけばタイムゾーンも変更可能です。ただし、どこでタイムゾーンが設定されているか後追いしづらいので、環境変数で設定できるなら環境変数を使った方が良いと思います。Dockerfile:Node.js(Express)

今回のアプリケーションの部分(サービス:app)は

appフォルダ配下

にExpressのソースが格納されています。それらのソースを元にDockerfileでコンテナを作成します。Dockerfile

# ベースイメージを指定 FROM node:10.12 # 環境変数設定 ENV NODE_ENV="development" # 作業ディレクトリ作成&設定 WORKDIR /src COPY ./app /src RUN npm install CMD npm run startここで重要なのでコンテナの中に

srcというフォルダを作成し、そこにホスト(自分の端末)のappフォルダの中身をコピーします。srcはWORKDIRに設定されているのでsrcでコピーしたソースファイルを元にnpm installなどを実行できます。今回は

Dockerfileでソースをコピーしましたがdocker-composeでも同じようなことが可能です。Node.js(Express)

ここは別記事にしてもよいくらい説明する箇所が多いので抜粋して記載します。今回の

Expressのソースではapp/routesフォルダのファイルでエンドポイントを設定して、表示内容をapp/viewsフォルダのテンプレートのファイルに渡してコンテンツを表示する流れになっています。処理の流れ app/routes → app/viewslocalhost:3000 にアクセス

app/routes/index.js ↓ app/views/index.ejs

index.jsではPostgresSQLのchatテーブルをセレクトした結果をindex.ejsに渡しています。localhost:3000/insert?msg=SEND_TEST

app/routes/insert.js ↓ app/views/index.ejs

insert.jsではURLパラメーターでmsgを受け取ることができます。msgの値をchatテーブルにインサートします。もしパラメーターがない場合は「ふにょふにょ」という値がインサートされます。表示する内容はindex.ejsと同じですがインサートされた後のテーブルの情報を表示します。

app/routesのファイルとapp/viewsのファイルは必ず1対1にする必要はなく、同じテンプレートでも渡す内容で表示内容を切り替えるなどの制御も可能だったりします。データベース(PostgresSQL)への接続:db_client.js

module.exports = { pg_client: function () { const { Client } = require('pg') const client = new Client({ user: process.env.DB_USER, host: process.env.DB_HOST, port: process.env.DB_PORT, database: process.env.DB_NAME }) return client }, pupupu: function () { console.log('pupupupu') } };

db_client.jsでデータベースの接続処理を共通で使用できるようにしています。PostgresSQLに必要なユーザー情報などはdocker-composeから環境変数で受け取りそれを元に接続を行います。総評

ある程度コンパクトにまとまっており、構成もそこまで複雑ではないかなと思いました。ただ開発するときに少し難があり

Expressは個別でnpm installなどでpackage.jsonなどを更新する必要があります。これはdocker-compose buildはappフォルダをコピーしているので、アプリのnode_moduleなどは手動で更新しないとコンテナで動作してくれません。逆にnpm startなどで開発すればよい話になりますが、データベースとの接続ができないので困ったところです。

しかしながら、今回の勉強会ではいろいろとdocker-composeについて理解を深めることができたのでよかったかなと思います。

- 投稿日:2020-06-30T08:36:32+09:00

コンテナイメージサイズ削減手法の効果

サービスインにかかる時間短縮等のため、コンテナイメージサイズはできるだけ小さくする必要があります。Dockerではイメージレイヤ数削減が、コンテナイメージサイズ削減の常套手段です。

しかし、マルチステージビルドが利用可能になったこともあり、コンテナイメージサイズ削減の手法ごとの効果を改めて調べてみました。

対象

- Dockerの概要は知っている人

- コンテナイメージサイズ削減手法の効果が知りたい人

サンプル

以下の条件でコンテナイメージサイズを比較します。

- ベースイメージ:nginx

- トップページ:ngixのLicenseページ

Debian

比較元となるコンテナイメージです。以下のDockerfileを使用します。

FROM nginx:latest WORKDIR /usr/share/nginx/html RUN apt-get update RUN apt-get upgrade -y RUN apt-get install -y wget RUN wget https://nginx.org/LICENSE -O index.htmlAlpine

ディストリビューションの変更によりコンテナイメージサイズ削減を図ります。以下のDockerfileを使用します。

FROM nginx:alpine WORKDIR /usr/share/nginx/html RUN apk update RUN apk upgrade RUN apk add wget RUN wget https://nginx.org/LICENSE -O index.htmlAlpine + &&結合

&&結合によりイメージレイヤ数削減を図ります。以下のDockerfileを使用します。

FROM nginx:alpine WORKDIR /usr/share/nginx/html RUN apk update &&\ apk upgrade &&\ apk add wget &&\ wget https://nginx.org/LICENSE -O index.htmlAlpine + マルチステージビルド

マルチステージビルドの利用により、イメージレイヤ数削減を図ります。マルチステージビルドはDocker ver 17.05以降で利用可能です。以下のDockerfileを使用します。

FROM alpine:latest AS build # .............................. A WORKDIR / RUN apk update RUN apk upgrade RUN apk add wget # ...................................... 1 RUN wget https://nginx.org/LICENSE -O index.html # ...... 2 FROM nginx:alpine # ........................................ B COPY --from=build /index.html /usr/share/nginx/html # ... 3上記のDockerfileの処理を解説します。

A. ビルド用コンテナ

B. 実行コンテナ

- ビルド用コンテナにwegetをインストールする

- ngixのLicenseページをindex.htmlとして保存する

- ビルド用コンテナのindex.htmlを実行コンテナのトップページとする

- ビルド用コンテナはイメージのビルドが終われば削除される

- 実行コンテナはアプリケーションの実行に必要なパッケージのみインストールすればよい

- よって、コンテナイメージサイズの削減が図れる

結果

Debian Alpine Alpine + &&結合 Alpine + マルチステージビルド ディストリビューション Debian Alpine Alpine Alpine メモリ使用量(MB) 152 25.7 25.6 21.3 結論

- ディストリビューションの変更によるコンテナイメージサイズ削減が最も効果が大きかった

- &&結合はイメージレイヤ数が多くないとコンテナイメージサイズ削減の効果を発揮しにくい

- イメージ削減の代償として、可読性も悪くなっている

- 本番用実行コンテナをローカル環境でテストできることが重要で、開発用実行コンテナと本番用実行コンテナとの構成は異なってよいのでは?

- ディストリビューションは共通で、開発時は可読性優先、本番用はコンテナイメージサイズ削減優先とすればよいのでは?

終わりに

コンテナイメージサイズ削減の手法と、手法ごとのコンテナのサイズをまとめました。可読性の問題も絡むため、コンテナイメージサイズ削減の手法はケースバイケースでよいのではないでしょうか。

参考

- 投稿日:2020-06-30T08:09:37+09:00

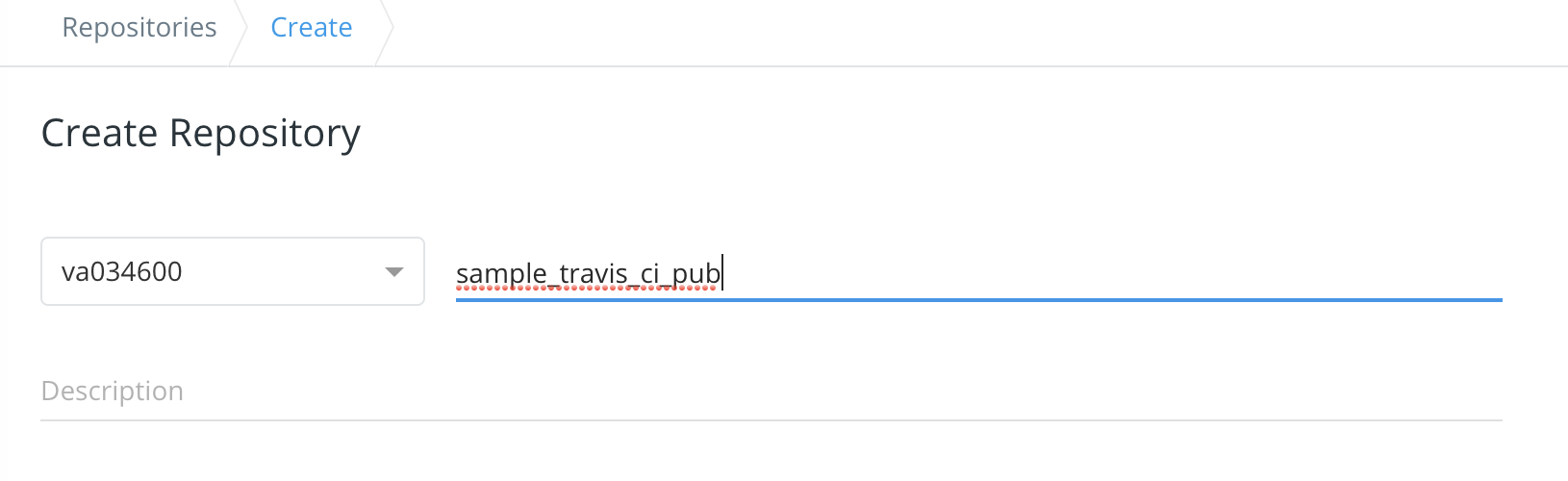

GitHub * TravisCI * Docker Repository(DockerHub, ECR)の連携

GitHub * TravisCI * Docker Repository の連携

TravisCI を使うことになりちょっと勉強しました。

CircleCIやGitLab CIとそんなに変わらないdockerが使えるCIです。ソースは github にあげました。

ファイル

Djangoの雛形作成

一応、Djangoの雛形作成した手順です。

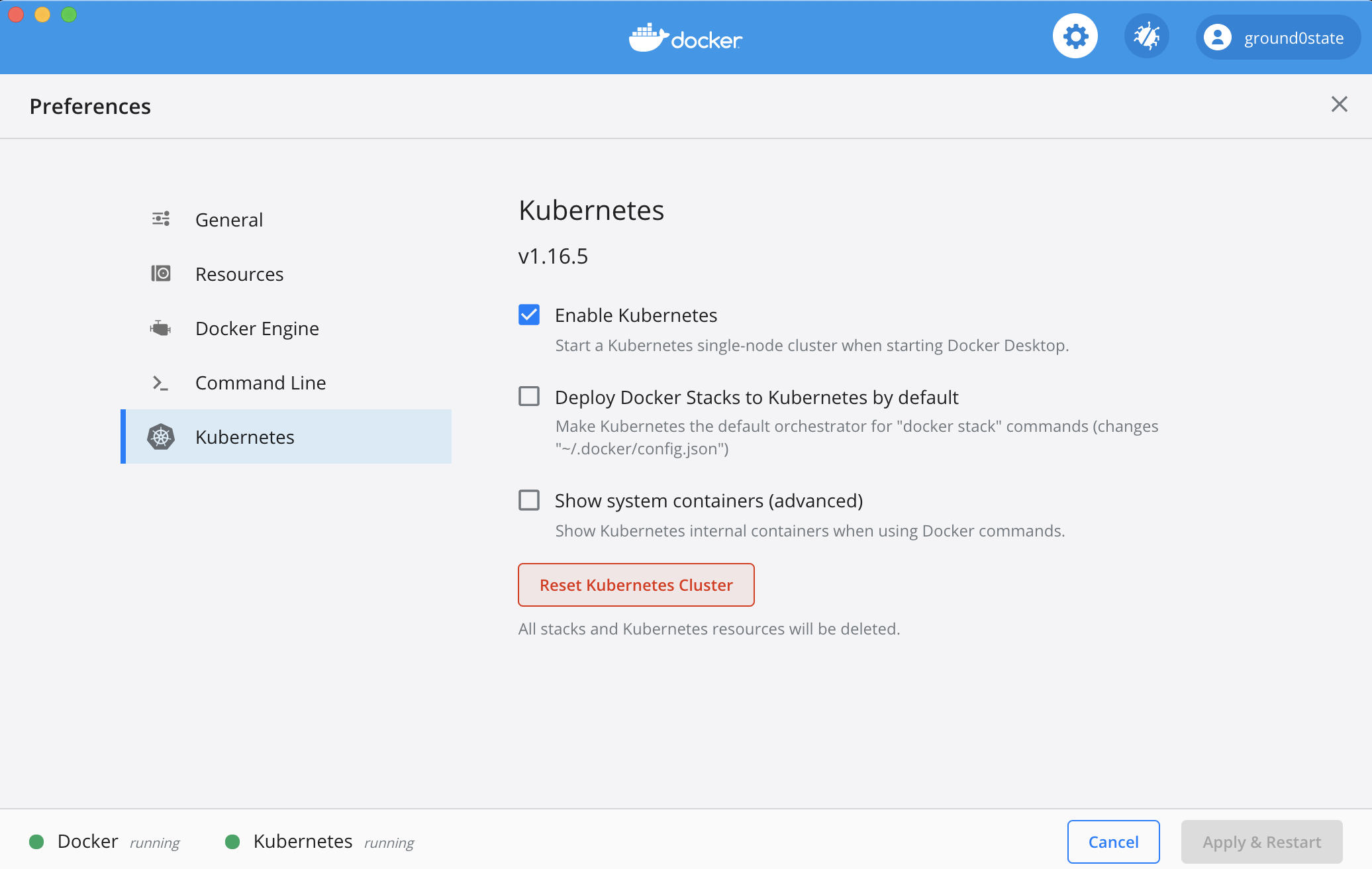

pyenv, Pipenvはセットアップ済です。$ pipenv --python 3.6 $ pipenv install django==2.2.3 $ pipenv shell (travis_ci) $ django-admin startproject travis_ci (travis_ci) $ cd travis_ci (travis_ci) $ python manage.py migrate.travis.yml

GitHubでタグを打ったら、Docker Hub, ECRにDjango雛形が入ったdockerイメージをプッシュします。

.travis.ymllanguage: python services: - docker env: global: - APP_NAME=sample_travis_ci # awscli - PATH=$HOME/.local/bin:$PATH # Docker Hub - DOCKER_HUB_ACCOUNT=va034600 # ECR - AWS_DEFAULT_REGION=ap-northeast-1 before_install: # ECR - pip install -U pip - pip install awscli script: - echo "script" after_success: - docker --version - docker build -t $APP_NAME:latest -f docker/Dockerfile . - docker images # Docker Hub - echo "$DOCKER_HUB_PASSWORD" | docker login -u "$DOCKER_HUB_ACCOUNT" --password-stdin # Docker Hub public - docker tag $APP_NAME:latest $DOCKER_HUB_ACCOUNT/${APP_NAME}_pub:${TRAVIS_TAG} - docker push $DOCKER_HUB_ACCOUNT/${APP_NAME}_pub:${TRAVIS_TAG} # Docker Hub private - docker tag $APP_NAME:latest $DOCKER_HUB_ACCOUNT/$APP_NAME:${TRAVIS_TAG} - docker push $DOCKER_HUB_ACCOUNT/$APP_NAME:${TRAVIS_TAG} # ECR - $(aws ecr get-login --no-include-email --region $AWS_DEFAULT_REGION) - docker tag $APP_NAME:latest $AWS_ECR_ACCOUNT.dkr.ecr.$AWS_DEFAULT_REGION.amazonaws.com/$APP_NAME:${TRAVIS_TAG} - docker push $AWS_ECR_ACCOUNT.dkr.ecr.ap-northeast-1.amazonaws.com/$APP_NAME:${TRAVIS_TAG} branches: only: - "/^v?[0-9\\.]+/"Dockerfile

FROM python:3.6.10 WORKDIR /usr/src/app RUN pip install --upgrade pip && pip install pipenv COPY ./Pipfile /usr/src/app/Pipfile COPY ./Pipfile.lock /usr/src/app/Pipfile.lock RUN pipenv install --system COPY . /usr/src/app/ CMD tail -f /dev/null各種サービスの設定

TravisCI

TravisCI の Environment Variablesの設定です。

Docker Repository(DockerHub)

Docker Repository(ECR)

ECR -> リポジトリ -> リポジトリ でrepositoryを作成しました。

起動

最後にDocker Hubに登録したdockerイメージをpullして起動確認しました。

docker-compose.yml

docker-compose.ymlversion: '3' services: api: image: va034600/sample_travis_ci_pub:v2.0.10 working_dir: /usr/src/app/travis_ci command: python manage.py runserver 0.0.0.0:8000 ports: - "8000:8000"$ docker-compose upブラウザで確認できたら終了です。

- 投稿日:2020-06-30T00:03:38+09:00

k8s-the-hard-way in Docker ~ Dockerコンテナ内でkubernetes-the-hard-wayしてみた

概要

kubernetes-the-hard-way を実践しようと思い、自宅環境に手軽に構築したいためにdockerコンテナ上に構築することを考えました。クラスタ構築の勉強方法の一つと捉えていただければ。

事実誤認や別の効率的なやり方等存じていたら教えていただければ幸いです。TL:DR

本稿は、k8sクラスタを手で構築しようとした筆者が詰まったポイントの備忘、もしくは同じくクラスタを構築したいという人がもしかしたら悩むかもしれないポイントの共有を目的としています。

そのため主に詰まったポイントと対処方法、リファレンスについて下記にまとめておきます。

詳細な内容については各章で触れていきます。

Issue Proposal Reference 各コンポーネントバイナリの実行時に”Operation not permitted”のエラー コンテナ実行時にcap_addする DockerCapability LinuxCapability SSL証明書関連で実行権がないと怒られる 署名時に該当のhostnameを追加し直す 本稿参照 /procや/sysへの書き込み権限がないと怒られる write権限を付与して該当のFSをマウント、もしくは再マウント 本稿参照 containerdバイナリ実行時に contained Not Found依存パッケージ( libseccomp-devlibc6-compat)のインストールref1, ref2 コンテナイメージをPullする際に x509: certificate signed by unknown authorityca-certificatesをインストールproject page servicesリソースへのアクセスができない ルーティングを追加 本稿参照 kube-proxyが write /sys/module/nf_conntrack/parameters/hashsize: operation not supported--conntrack-max=0を付加ref kubelet起動時の権限不足 tmpfsをマウント 本稿参照 はじめに

基本的にgcpの機能は使えないということと、dockerの機能で抑制されている部分を変更する必要がありました。

以下、k8s-the-hard-wayのチュートリアル(以降:本家)に沿ってそれぞれ解説していきます。

構築環境は、VirtualBOX上にCPU:1, RAM:4Gi, Disk:32GiのCentos8をminimalインストールした状態です。centos7でも同様の手順で問題なく動くこと実験済みです。環境情報$ cat /etc/redhat-release CentOS Linux release 8.1.1911 (Core) $ grep cpu.cores /proc/cpuinfo cpu cores : 1 $ lsblk | grep disk sda 8:0 0 32G 0 disk $ grep MemTotal /proc/meminfo MemTotal: 3871792 kB $ docker --version Docker version 19.03.8, build afacb8b01-prerequisites

GoogleクラウドのCLI導入およびアカウント登録。

本稿では不要なので割愛。02-client-tools

SSL証明書系の作成ツール(cfssl, cfssljson)およびkubernetes操作用のCLIツール(kubectl)の導入。

証明書一連の作業はその他のコマンドでも可能ですが、cfsslは公開鍵通信用の鍵作成から署名要求(CSR: Certificate Signing Request)、CAによる署名までを一気に行うことが可能なので、導入しておくことが好ましいです、素直にインストラクションに従います。

ちなみにcfsslは鍵のjson形式での出力、cfssljsonで鍵ファイルの保存を行います。$ { curl -O https://storage.googleapis.com/kubernetes-the-hard-way/cfssl/linux/cfssl curl -O https://storage.googleapis.com/kubernetes-the-hard-way/cfssl/linux/cfssljson chmod +x cfssl cfssljson mv cfssl cfssljson /usr/local/bin/ } # 1.3.4 >= であることを確認 $ cfssl version Version: 1.3.4 Revision: dev Runtime: go1.13 $ cfssljson --version Version: 1.3.4 Revision: dev Runtime: go1.13次にkubectlを同様にしてインストール。

こちらはkubernetesのいわば神経系とも言うべきkube-apiサーバに対しリクエストをなげるためのバイナリです。

k8sを扱う際、基本全てkube-api経由で管理することになりますが、例えばクラスタ内のワーカーノードの情報を取得したいといった場合に

curl -X GET --cacert ../ca/ca.pem --cert admin.pem --key admin-key.pem https://balancer:443/api/v1/nodes

とGETリクエストを出し、帰ってきたJSON形式の文字列を処理して・・・といったような面倒くさいことになります。しかしこちらのバイナリを使えば

kubectl get no

と、3単語入れるだけで情報の取得から人間に読みやすい形への整形・出力を勝手にしてくれます。

素のAPI経由での操作が気になればReferenceを読むといいと思います(丸投げ

とてもいい感じにAPIサーバとのやりとりが書かれている記事もありました

→転職したらKubernetesだった件kubectl-install$ { curl -O https://storage.googleapis.com/kubernetes-release/release/v1.15.3/bin/linux/amd64/kubectl chmod +x kubectl sudo mv kubectl /usr/local/bin/ # 1.15.3 >= kubectl version --client }outputClient Version: version.Info{Major:"1", Minor:"18", GitVersion:"v1.18.2", GitCommit:"52c56ce7a8272c798dbc29846288d7cd9fbae032", GitTreeState:"clean", BuildDate:"2020-04-16T11:56:40Z", GoVersion:"go1.13.9", Compiler:"gc", Platform:"linux/amd64"}03-compute-resources

本家ではGCP上にVPCの作成とインスタンスの作成を行なっているが、本稿ではここをDockerコンテナに置き換えます。