- 投稿日:2019-07-01T23:54:53+09:00

【Python】2次元配列を二番目の要素に注目して降順にソートする

はじめに

自分が忘れないように書き留めたものです。

n番目の要素に着目してソートするのは知らない人は苦労するかも?と思って記事にしてみました。

ついでにsortedにおける降順ソートのやり方も紹介してます。コード

li = [[1,4,3],[2,3,4],[3,4,5],[4,5,6],[2,3,4],[1,5,3],[2,3,4],[5,6,7]] li = sorted(li, reverse=True, key=lambda x: x[1]) #[1]に注目してソート print(li)keyにlambdaを使って関数を渡しているところがポイントです。key関数はソートに利用される何かしらを返す必要があります。

言い換えれば、key関数が示すのはリストの各要素に対して行う前処理です。

上記の例でいえば、[1,4,3]という0番目の要素をkey関数に渡し、仮引数xで受け取ります。その後、x[1]すなわち二番目の要素([1,4,3]の内の4)を返す処理を行います。この返ってきた値をソートの基準として用います。

これを全ての要素について行うことで、ソートする基準として二番目の要素を使うことができるようになるわけです。

また、reverse = Trueとすることで降順ソートも実現しています。実行結果

[[5, 6, 7], [4, 5, 6], [1, 5, 3], [1, 4, 3], [3, 4, 5], [2, 3, 4], [2, 3, 4], [2, 3, 4]]結論

結構簡単です。

他にもkey関数でやれることは色々あるので知りたい方はこちらの公式ドキュメントをご覧ください。

凄くわかりやすいと思います。

- 投稿日:2019-07-01T23:40:00+09:00

NumPyで乱数を扱う

乱数を扱う

乱数と一言で言うけども、色々な種類の乱数があるので、いくつかNumPyを使って作ってみる

乱数生成だけでなくランダムチョイス等も見ていく

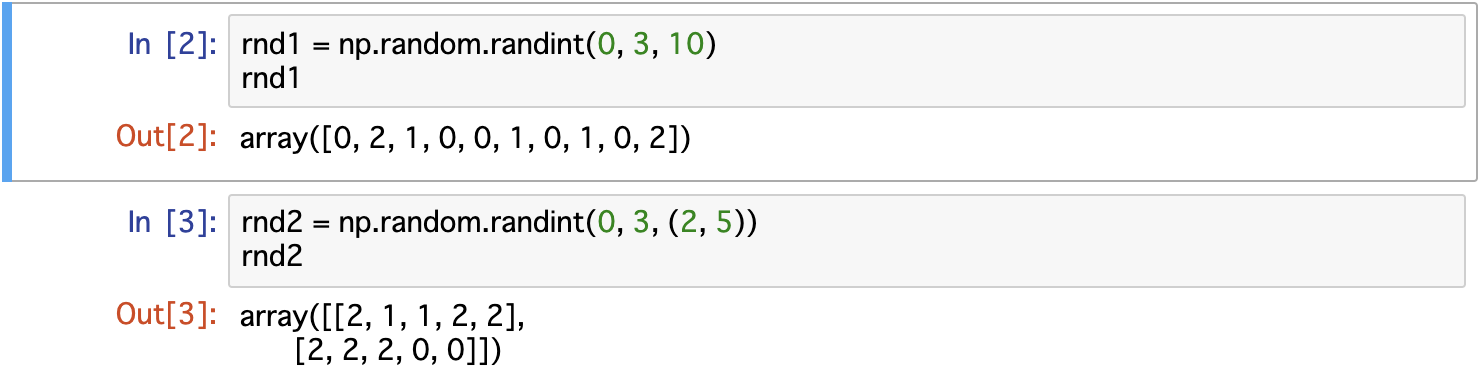

つまりnumpy.randomモジュールについて一様乱数

特定の範囲の実数が均等な確率で発生する、まさに一様に発生する乱数

範囲の指定をしないものはデフォルトで0以上1未満で生成される1次元の一様乱数

numpy.random.rand(要素数)で作れる

random.randとなるのが若干ややこしいな2次元の一様乱数

もはやパターンかなと思いきや、タプルで指定ではなく、第1、2引数だ

範囲指定の一様乱数

numpy.random.uniformで作れる

uniform(3, 5, 10)で3以上5未満で10個を表す2次元も同様に

この場合はお決まりのタプルで渡す必要があるのか、注意整数乱数

名前がすべてだが、特定の範囲の整数が同じ確率で発生する乱数

一様乱数と同様の部分は端折る整数乱数

numpy.random.randintで作れる

引数については一様乱数と同様

ランダムなリスト操作

ランダムに洗濯

洗濯じゃない選択(洗濯はランダムにしない)

choiceを使う

指定回数選択

numpy.random.choice(targets, 4)でtargetsリストから4つ選択(回数は問わない)1度だけ選択

1度だけ選択される(リスト内で重複があれば当然重複もする)

replace=Falseで1度しか出現しなくなるランダムに並び替え

長くないリストであれば、 choice(targets, 3, replace=False) で1度だけ選択するより

この並び替えを使うと良い

長いリストの場合はchoiceする方が効率は良いその他様々な分布の乱数

標準正規乱数

numpy.random.randnで作れる

デフォルトだと、平均が0 標準偏差1の正規分布になる

標準偏差については詳しくはWebでだが、散らばりの度合いを示したもの正規乱数

numpy.random.normalで作れる

平均が50 標準偏差10 の乱数10個

つまり正規分布? 本格的に統計学(?)、分布とかの勉強しないと理解に苦しむなぁ。。。

多次元も

ベータ乱数

numpy.random.betaで作れる

- ベータ分布

- 軽く読んだけどマジムリ...

- 軽くじゃダメそうなので、ちゃんとそれ用に時間を取って理解した方が良さげ

二項乱数

numpy.random.binomialで作れる

- 二項分布 (これはまだわかる!)

- 成功か失敗の結果を持つ試行を

n回繰り返した時の分布- 成功率

pは一定とする

この場合は、 成功率 p = 0.4 の試行を10回やった時の成功回数、を 10個ポアソン乱数

numpy.random.poisson

調べてみたけどよくわからない系の分布でした・・・

単位時間あたり平均でλ回発生する事象の発生回数の分布

どういう時に使われるかだけあげておくと、

- 交番の事故の件数

- 30分に平均2回電話がかかって来るコールセンターで、1時間に6回電話がかかって来る確率

だそうです

λ = 0.8 のポアソン乱数10個

↑これ何!!!わからなすぎるので一旦保留だな

多次元正規乱数

numpy.random.multivariate_normalで作れる

正規乱数並みの難易度かと思いきや...

平均が[0, 0] 共分散行列が [[1, 0.5], [0.5, 1]] の多次元正規乱数もはや調べるのも無駄な抵抗なので、いつかちゃんとやる

乱数の再現性

numpyなどで生成される乱数は全て擬似乱数と言って、必ずシードを元に生成される

シードは実行環境の初回実行時の時刻等で初期化される

なので、明示的にシードの指定をしなくても乱数が発生させられる

(個人的なイメージ: ビンゴカードのようなもの? 初回実行時に新しいビンゴカードが配られる)

何度実行しても同じ乱数が出ることを再現性があるという

- 再現性のある乱数を発生させる方法

- 最初にシードを指定 (同じビンゴカードを使う)

- 状態を取得して、再現したいときに状態を設定 (状況に応じてビンゴカードの数字を変えちゃう?)

シード指定

seed(0)で固定しているので、何度実行しても同じになる状態設定

get_state/set_stateで取得、設定する

3行は常に同じだが、実行するたびに値は変わるファイルに保存

ファイルに保存して、それを読み込むことでも、再現性があると言える感想

様々な乱数を見てきたけど、分布、統計という前提条件の壁がかなり高いことがわかってしまった

実践とまで言わずとも、自分で何かやってみようという段階になるまでには

まだまだ長い道のりになりそうだー

- 投稿日:2019-07-01T23:39:31+09:00

Pythonのcsv出力

import pandas as pd

file = []for i in range(1,10,1):

file.append(i)file = pd.DataFrame(file)

file.to_csv('test.csv')

- 投稿日:2019-07-01T23:25:02+09:00

SocketCAN対応のCANalyzeをWindowsで使う

概要

- 本記事の想定対象者

- 車載ネットワークであるCAN通信をWindowsから安価なデバイス(CANalyze等)かつPythonで行いたい方

- libusb/WinUSBドライバー経由でデバイスをPythonから制御してみたい方(PyUSB使用)

- Linux上でのUSB通信の解析方法の例を知りたい方(usbmon使用)

- CAN通信をPythonから行う場合、LinuxでSocketCANやSerial can(slcan)対応のデバイス(PCAN,CANalyze,USBCAN,...)を使用すると安価で便利

- しかし、WindowsにはSocketCANという概念が無いため、slcan相当のデバイスを使用するしかなかった(他にも下記方法があるようだが、それ以外は単に知らない)

- 他の方法としては、CANALドライバー(usb2can.dll(32bit))を使用してusb 8dev対応のPCANなどに接続する方法があるが、手元のCANalyzeではデバイスが見つからないとエラーが出てうまくいかなかった

- そこで、linuxのusb 8devドライバー対応のCAN通信デバイス(CANalyze)のファームウェアソースコードを解析し、Windowsでlibusb/WinUSBドライバー経由でSocketCAN対応のデバイスにも接続できるようにした

- CANalyzeに対するlibusb(32bit)/WinUSB(64bit)ドライバーの適用にはzadigを使用した

- Pythonを使用しているが、C言語等でもlibusb経由で同様のコマンドを送受信すればCAN通信が行えるはず

デバイス準備

- usb 8dev対応デバイス(ここではCANalyze)を調達する

USB通信の解析

- まずLinux上で利用した際のUSB通信を解析する。以下の手順で送受信を行う ```bash # apt-get install can-utils # ip link show can0が存在することを確認 # ip link set can0 type can bitrate 500000 # ip link set can0 up # cansend can0 123#1122334455667788 # candump can0

Ctrl^C

ip link set can0 down

- usbmonドライバーのインストールとデバイスの確認 ```bash # modprobe usbmon # cat /sys/kernel/debug/usb/devices T: Bus=02 Lev=02 Prnt=03 Port=00 Cnt=01 Dev#= 5 Spd=12 MxCh= 0 D: Ver= 2.00 Cls=00(>ifc ) Sub=00 Prot=00 MxPS=64 #Cfgs= 1 P: Vendor=0483 ProdID=1234 Rev= 1.00 S: Manufacturer=STMicroelectronics S: Product=USB2CAN converter S: SerialNumber=205236****** C:* #Ifs= 1 Cfg#= 1 Atr=00 MxPwr=100mA I:* If#= 0 Alt= 0 #EPs= 4 Cls=ff(vend.) Sub=ff Prot=ff Driver=usb_8dev E: Ad=81(I) Atr=02(Bulk) MxPS= 64 Ivl=0ms E: Ad=02(O) Atr=02(Bulk) MxPS= 64 Ivl=0ms E: Ad=83(I) Atr=02(Bulk) MxPS= 64 Ivl=0ms E: Ad=04(O) Atr=02(Bulk) MxPS= 64 Ivl=0ms USB2CAN converter(CANalyze)のUSB論理構成 └ Interface:1 (usb_8dev) ├ Endopint:1 Bulk Input (USB調査よりData入力用) ├ Endopint:2 Bulk Output (USB調査よりData出力用) ├ Endopint:3 Bulk Input (USB調査よりCommand入力用) └ Endopint:4 Bulk Output (USB調査よりCommand出力用)

- ip link set can0~, ip link set can0 upを実行した際のUSB通信の解析

# ip link set can0 type can bitrate 500000 # ip link set can0 up 別ターミナル(事前に起動しておく) # cat /sys/kernel/debug/usb/usbmon/2u ※cat /sys/kernel/debug/usb/devicesの "T: Bus=02" より2uを使用 ffff880232886d80 3205323523 S Bo:2:007:4 -115 16 = 11000209 000d0201 00040000 00080022 ※Endpoint:4でのbulk送信 ffff880232886d80 3205450861 C Bi:2:007:3 0 16 = 11000200 00000100 01000000 00000022 ※Endpoint:3でのbulk送信 ※Bo/Biの意味はUSBのBulk通信のIn/Outという意味 Ci Co Control input and output Zi Zo Isochronous input and output Ii Io Interrupt input and output Bi Bo Bulk input and output ※ 送信データの解析 "11 00 02 09 00 0d020100040000000800 22" /* Format of both received and transmitted USB command messages. */ typedef struct __packed usb_8dev_cmd_msg { uint8_t start; // start of message byte uint8_t channel; // unknown - always 0 uint8_t command; // command to execute uint8_t opt1; // optional parameter / return value uint8_t opt2; // optional parameter 2 uint8_t data[10]; // optional parameter and data uint8_t end; // end of message byte } Msg_CmdTypeDef; // https://github.com/kkuchera/canalyze-fw/blob/master/src/usbd_8dev_if.c

- ip link set can0 downを実行した際のUSB通信の解析

# ip link can0 down 別ターミナル(事前に起動しておく) # cat /sys/kernel/debug/usb/usbmon/2u ffff880232886cc0 3256831570 S Bo:2:007:4 -115 16 = 11000300 00000000 00000000 00000022 ffff880232886cc0 3256843005 C Bi:2:007:3 0 16 = 11000300 00000100 01000000 00000022

- cansendのUSB通信取得

# cansend can0 555#1122334455667788 別ターミナル(事前に起動しておく) # cat /sys/kernel/debug/usb/usbmon/2u ffff880232887980 3421490964 S Bo:2:007:2 -115 16 = 55000000 05550811 22334455 667788aa ※Endpoint:2でのbulk送信 # cansend can0 777#8888888888888888 別ターミナル(事前に起動しておく) # cat /sys/kernel/debug/usb/usbmon/2u ffff8802328866c0 3619076135 S Bo:2:007:2 -115 16 = 55000000 07770888 88888888 888888aa

- cansendのUSB通信を解析

55 00 00000555 08 1122334455667788 aa 55 00 00000777 08 8888888888888888 aa ^^USB_8DEV_DATA_START=0x55 ^^^^^^^^ID(標準11bit, 拡張29bit) ^^DLC(1byte) ^^^^^^^^^^^^^^^^Data(8bye 0x00パディング) ^^USB_8DEV_DATA_END=0xAA /* Format of received USB data messages. */ typedef struct __packed usb_8dev_rx_msg { uint8_t start; // start of message byte uint8_t flags; // RTR and EXT_ID flag uint32_t id; // upper 3 bits not used uint8_t dlc; // data length code 0-8 bytes uint8_t data[8]; // 64-bit data uint8_t end; // end of message byte } Msg_RxTypeDef;

- candumpのUSB通信取得

# candump can0 別ターミナル(事前に起動しておく) # cat /sys/kernel/debug/usb/usbmon/2u ffff880232886cc0 3667542562 C Bi:2:007:1 0 21 = 55000100 00055508 11223344 55667788 e65e0700 aa ※Endpoint:1でのbulk受信 ※ID 0x555, 0x1122334455667788を受信 ffff8800b8d76c00 220316803 C Bi:2:008:1 0 21 = 55000100 00077708 88888888 88888888 b0990000 aa ※Endpoint:1でのbulk受信 ※ID 0x777, 0x8888888888888888を受信

- candumpのUSB通信を解析

55 00 01 00000555 08 1122334455667788 e65e0700 aa 55 00 01 00000777 08 8888888888888888 b0990000 aa ^^USB_8DEV_DATA_START=0x55 ^^type ^^flags ^^^^^^^^ID(標準11bit, 拡張29bit) ^^DLC(1byte) ^^^^^^^^^^^^^^^^Data(8bye 0x00パディング) ^^^^^^^^timestamp ^^USB_8DEV_DATA_END=0xAA /* Format of transmitted USB data messages. */ typedef struct __packed usb_8dev_tx_msg { uint8_t start; // start of message byte uint8_t type; // frame type uint8_t flags; // RTR and EXT_ID flag uint32_t id; // upper 3 bits not used uint8_t dlc; // data length code 0-8 bytes uint8_t data[8]; // 64-bit data uint32_t timestamp; // 32-bit timestamp uint8_t end; // end of message byte } Msg_TxTypeDef;Python on windowsでの制御

- Windowsで行っているがlibusb経由であればLinuxでも使えるはず。但しLinuxの場合SocketCANの方が対応ツールも多く便利

ドライバーのインストール

- zadigを使用して、Options > List All Devicesを選択 > リストボックスから"USB2CAN converter"(=CANalyze)を選択

- Pythonの32/64bitに合わせてドライバーをインストールする。32bitの場合はlibusb-win32を、64bitの場合はWinUSB(例、下図)を選択

pythonでの通信

""" # pip install can # pip install pyusb """ import binascii import usb.core import usb.util USB_8DEV_CMD_START = 0x11 USB_8DEV_CMD_END = 0x22 USB_8DEV_DATA_START = 0x55 USB_8DEV_DATA_END = 0xAA USB_8DEV_OPEN = 0x2 USB_8DEV_CLOSE = 0x3 USB_8DEV_GET_SOFTW_HARDW_VER= 0xC def init(): dev = usb.core.find(idVendor=0x0483, idProduct=0x1234) dev.set_configuration() cfg = dev.get_active_configuration() itfs = cfg[(0,0)] dat_in = usb.util.find_descriptor(itfs, bEndpointAddress=0x81) dat_out = usb.util.find_descriptor(itfs, bEndpointAddress=0x2) cmd_in = usb.util.find_descriptor(itfs, bEndpointAddress=0x83) cmd_out = usb.util.find_descriptor(itfs, bEndpointAddress=0x4) s = [dat_in, dat_out, cmd_in, cmd_out] return s def send_wait_cmd(s, msg): cmd_in, cmd_out = s[2], s[3] if cmd_out.write(msg) != len(msg): print("send error") return cmd_in.read(128) def make_cmd(command, opt1 = 0, opt2 = 0, data = ""): channel = 0 dlc_max = 8 data += "0" * (2*dlc_max - len(data)) msg = "1100%02x%02x%02x%s22" % (command, opt1, opt2, data) return binascii.unhexlify(msg) def version(s): # get firmwate and hardware version msg = make_cmd(USB_8DEV_GET_SOFTW_HARDW_VER, data="00"*10) ret = send_wait_cmd(s, msg) print(ret) def open(s): ctrlmode = 0x08 msg = make_cmd(USB_8DEV_OPEN, opt1=0x09, data="0d02010004000000%02x00" % ctrlmode) ret = send_wait_cmd(s, msg) print(ret) def close(s): msg = make_cmd(USB_8DEV_CLOSE, data="00"*10) ret = send_wait_cmd(s, msg) print(ret) def make_dat(flags, id, data = ""): # flags : RTR and EXT_ID (USB_8DEV_EXTID) flag # id : 11 / 29bit dlc = len(data) if len(data)%2 != 0: data = "0" + data data += "00" * (8-dlc) msg = "55%02x%08x%02x%saa" % (flags, id, dlc, data) return binascii.unhexlify(msg) def send(s, msg_id, data): dat_out = s[1] msg = make_dat(flags = 0, id = msg_id, data = data) if dat_out.write(msg) != len(msg): return False return True def recv(s, timeout = 1000): dat_in = s[0] msg = dat_in.read(64, timeout = timeout) if msg[0] != USB_8DEV_DATA_START or msg[-1] != USB_8DEV_DATA_END or 13 + msg[7] != len(msg): return None frame_type, flags, id, dlc, data, timestamp = msg[1], msg[2], msg[3:7], msg[7], msg[8:-5], msg[-5:-1] id = (((((id[0]<<8) + id[1])<<8) + id[2])<<8) + id[3] data = [i for i in data] timestamp = (((((timestamp[3]<<8) + timestamp[2])<<8) + timestamp[1])<<8) + timestamp[0] return [id, data, timestamp]送受信テスト

s = init() open(s) msg_id = 0x7ff data = "1122334455667788" send(s, msg_id, data) while 1: ret = recv(s) if ret is not None: break msg_id, data, timestamp = ret close(s)

- 投稿日:2019-07-01T22:05:44+09:00

Pythonプロジェクトのパッケージング例

- 投稿日:2019-07-01T21:56:49+09:00

DjangoでサクッとWebサイトを作る Part1

DjangoでサクッとWebページを作ってみました。

初心者向けに超基礎的な部分だけ解説します。セットアップ

既にご存知かと思いますが、DjangoはPythonで開発されています。したがってまずはPythonをインストールする必要があります。

本記事執筆辞典ではPythonは3.7がおすすめです。もしPython2.xがインストール済の場合はアップグレードしましょう。インストールが正しく行われているか確認するには以下のコードを実行してみてください。

$ python3 --version Python 3.6.1Djangoのインストール

projects/requirements.txtファイル中に以下のテキストを追加します。Django~=2.0.6次に、以下のコードを実行してインストールします。

pip install -r requirements.txt以下のようになりましたでしょうか。

(myvenv) ~$ pip install -r requirements.txt Collecting Django~=2.0.6 (from -r requirements.txt (line 1)) Downloading Django-2.0.6-py3-none-any.whl (7.1MB) Installing collected packages: Django Successfully installed Django-2.0.6インストールはこれで完了です。

次回は具体的な開発の解説に入っていこうと思います。最終的にはこんな感じになります

LeadingTech更新はゆっくりになりますが頑張りますので気長にお待ちください!

- 投稿日:2019-07-01T21:09:36+09:00

FoxDotによるLiveCoding方法のまとめ

LiveCodingをご存じでしょうか?

∀RroWsの次のライヴの一部は音楽と映像Wでライヴコーディングしようと言うことになったので、どっちもいけるようにしておかないと。音楽はFoxDotものにしないと。映像はTouchDesignerでやるかな。 pic.twitter.com/2MqHMXtSEj

— Tomoya@∀RroWs (@snufkinliberty) 2019年2月25日これは始めたばかりの頃のもので拙いですが、要はプログラミングでリアルタイムに音楽や映像を作るパフォーマンスをすることを言います。

音楽の場合、PythonによるLiveCoding環境としてFoxDotがあります。

他にもTidalCyclesなどありますが、なじみのPythonでできるのがいいなとFoxDotを始めました。FoxDotのサイトのTopPageのYouTubeのパフォーマンスがかっこいいです。

https://foxdot.org/僕は∀RroWsという電子音楽とデジタルアートのユニットをやっており、ぜひ次回のライヴでLiveCodingに挑戦したいということで、学んだことを随時、本記事にまとめていきたいと思います。

インストール方法

インストール方法は下記の記事がそのまま参考になります。

https://qiita.com/Hulc_0418/items/ba3e94633e465f7201d0本家サイトのインストールガイドはこちら

https://foxdot.org/installation/FoxDotの立ち上げ方法

Windowsの場合ですが、

①SuperColliderを立ち上げて、左の入力欄にFoxDot.startを入力して、Ctrl+Enter

②コマンドプロンプトを立ち上げて、python -m FoxDotを入力、Enterすると開始できる。

音の再生と停止

再生:例えばp1 >> pluck()を入力し、Ctrl+Enterで音が鳴る。

この時、行が連続している場合、これらがまとめて実行される。

停止:p1.stop()でp1が停止する。

全停止 Clock.clear()曲の設定

テンポ:Clock.bpm = 175

スケール(デフォルト:major):Scale.default = Scale.minorなどと指定

オクターブ:p1.oct = 5とp1など個別に音域を数値で指定演奏の基本

p1 >> pluck():引数なしでは4つうち

p1 >> pluck([0,2,4], dur=[1,1/2,1/2], amp=[1,3/4,3/4],pan=[-1,0,1])

音程:[ ]のみで指定

例) ドレミファソラシド p1 >> pluck([0,1,2,3,4,5,6,7])

dur:音の長さ 1が1拍(4分音符)、1/2が1/2拍(8分音符)

amp:音量

pan:LRチャンネル-1でL:100%, 1でR:100%,0(なし)でCenter

音色:print(SynthDefs)で確認できる。

plunkの部分を例えば以下のように変更すれば良い。

Lead系

star, soft, quin, saw, varsaw, lazerなど

Pad系

charm, prophet, pads, ambi, space, keys, klank, feel, glassなど

ベース系

bass, jbass, sawbass, dbass, dirt, dabなどドラム

d1 >> play("")

""に以下を記述

・休符は半角スペース

・音色は print(Samples)で確認できる

以下音色キック

'V': Hard kick

'v': Soft kick

'X': Heavy kick

'x': Bass drum

'A': Gameboy kick drum

スネア

'O': Heavy snare

'o': Snare drum

'I': Rock snare

'i': Jungle snare

'D': Dirty snare

'u': Soft snare

't': Rimshot

ハット系

'-': Hi hat closed

'=': Hi hat open

':': Hi-hats

'a': Gameboy hihat

'~': Ride cymbal

'#': Crash

'R': Metallic

'r': Metal

タム

'm': 808 toms

'M': Acoustic toms

クラップ

'*': Clap

'H': Clap

パーカス

'!': Yeah!

'$': Beatbox

'%': Noise bursts

'&': Chime

'+': Clicks

'T': Cowbell

'e': Electronic Cowbell

'E': Ringing percussion

'd': Woodblock

's': Shaker

'k': Wood shaker

ヒット

'K': Percussive hits

'L': Noisy percussive hits

'w': Dub hits

'y': Percussive hits

その他

'1': Vocals (One)

'2': Vocals (Two)

'3': Vocals (Three)

'4': Vocals (Four)

'F': Trumpet stabs

'G': Ambient stabs

'J': Ambient stabs

'q': Ambient stabs

'Q': Electronic stabs

'Z': Loud stabs

'n': Noise

'l': Robot noise

'@': Gameboy noise

'/': Reverse sounds

'B': Short saw

'C': Choral

'N': Gameboy SFX

'P': Tabla long

'S': Tamborine

'U': Misc. Fx

'W': Distorted

'Y': High buzz

'\': Lazer

'^': 'Donk'

'b': Noisy beep

'c': Voice/string

'f': Pops

'g': Ominous

'h': Finger snaps

'j': Whines

'p': Tabla

'z': Scratch

'|': Hangdrum随時、追加更新します。

- 投稿日:2019-07-01T21:09:36+09:00

FoxDotによるLiveCoding方法1

LiveCodingをご存じでしょうか?

∀RroWsの次のライヴの一部は音楽と映像Wでライヴコーディングしようと言うことになったので、どっちもいけるようにしておかないと。音楽はFoxDotものにしないと。映像はTouchDesignerでやるかな。 pic.twitter.com/2MqHMXtSEj

— Tomoya@∀RroWs (@snufkinliberty) 2019年2月25日これは始めたばかりの頃のもので拙いですが、要はプログラミングでリアルタイムに音楽や映像を作るパフォーマンスをすることを言います。

音楽の場合、PythonによるLiveCoding環境としてFoxDotがあります。

他にもTidalCyclesなどありますが、なじみのPythonでできるのがいいなとFoxDotを始めました。FoxDotのサイトのTopPageのYouTubeのパフォーマンスがかっこいいです。

https://foxdot.org/僕は∀RroWsという電子音楽とデジタルアートのユニットをやっており、ぜひ次回のライヴでLiveCodingに挑戦したいということで、学んだことを随時、本記事にまとめていきたいと思います。

インストール方法

インストール方法は下記の記事がそのまま参考になります。

https://qiita.com/Hulc_0418/items/ba3e94633e465f7201d0本家サイトのインストールガイドはこちら

https://foxdot.org/installation/FoxDotの立ち上げ方法

Windowsの場合ですが、

①SuperColliderを立ち上げて、左の入力欄にFoxDot.startを入力して、Ctrl+Enter

②コマンドプロンプトを立ち上げて、python -m FoxDotを入力、Enterすると開始できる。

音の再生と停止

再生:例えばp1 >> pluck()を入力し、Ctrl+Enterで音が鳴る。

この時、行が連続している場合、これらがまとめて実行される。

停止:p1.stop()でp1が停止する。

全停止 Clock.clear()曲の設定

テンポ:Clock.bpm = 175

スケール(デフォルト:major):Scale.default = Scale.minorなどと指定

オクターブ:p1.oct = 5とp1など個別に音域を数値で指定演奏の基本1 シンセ(メロディ)

p1 >> pluck():引数なしでは4つうち

p1 >> pluck([0,2,4], dur=[1,1/2,1/2], amp=[1,3/4,3/4], pan=[-1,0,1])

音程:[ ]のみで指定

例) ドレミファソラシド p1 >> pluck([0,1,2,3,4,5,6,7])

dur:音の長さ 1が1拍(4分音符)、1/2が1/2拍(8分音符)

amp:音量

pan:LRチャンネル-1でL:100%, 1でR:100%,0(なし)でCenter

音色:print(SynthDefs)で確認できる。

plunkの部分を例えば以下のように変更すれば良い。

Lead系

star, soft, quin, saw, varsaw, lazerなど

Pad系

charm, prophet, pads, ambi, space, keys, klank, feel, glassなど

ベース系

bass, jbass, sawbass, dbass, dirt, dab など演奏の基本2 ドラム(リズム)

d1 >> play("")

""に以下を記述

・休符は半角スペース

・音色は print(Samples)で確認できる

以下音色キック

'V': Hard kick, 'v': Soft kick, 'X': Heavy kick, 'x': Bass drum,

'A': Gameboy kick drum

スネア

'O': Heavy snare, 'o': Snare drum, 'I': Rock snare, 'i': Jungle snare

'D': Dirty snare, 'u': Soft snare, 't': Rimshot

ハット系

'-': Hi hat closed, '=': Hi hat open, ':': Hi-hats, 'a': Gameboy hihat

'~': Ride cymbal, '#': Crash, 'R': Metallic, 'r': Metal

タム

'm': 808 toms, 'M': Acoustic toms

クラップ

'*': Clap, 'H': Clap など

基本の8ビート

Xがバスドラ、Iがスネア、=がハイハットオープン、-がハイハットクローズド、スペースが休符

まずは、このようにパート毎に書くとDTMなどで打ち込みをやっている人には分かりやすい。

ただし、LiveCodingとしては、これを入力するのに時間がかかるので短く書く必要がある。短くする方法の例:繰り返しは省略する

("")の中は繰り返されるので、Xは拍の頭だけ鳴らすなら"X "と1拍分だけで良い。

Iは2,4拍目なので、" I "で2拍分書けば良い。

"(=-)---"は"=-------"と同じ。つまり、ドラムの場合は()を付けると、1回目は1番目の=がなり、2回目は-が鳴るを繰り返す。続く

- 投稿日:2019-07-01T20:46:25+09:00

【Python】JR西日本の指定路線の1分以上遅延のある電車を調べる

JR西日本の指定路線で1分でも遅延している電車を調べてみる。

JSONのありかは「https://www.train-guide.westjr.co.jp/api/v3/」に

https://www.train-guide.westjr.co.jp/area_kinki.html

から各路線のファイル名+.jsonで大阪環状線の場合、

import json import urllib.request try: url = 'https://www.train-guide.westjr.co.jp/api/v3/osakaloop.json' res = urllib.request.urlopen(url) data = json.loads(res.read().decode('utf-8')) for item in data['trains']: if item['delayMinutes'] > 0: print(item['displayType'], item['dest']['text'],'行き:',item['delayMinutes'],'分遅れ') except urllib.error.HTTPError as e: print('HTTPError: ', e) except json.JSONDecodeError as e: print('JSONDecodeError: ', e)後々したいこと

列車位置情報アプリが10分以上の遅れしか通知してくれないので、cronとかで定期的に実行とかでslackに送りつけるとかしたい

- 投稿日:2019-07-01T20:24:50+09:00

[python+swift] リアルタイムで信号色を認識するiOSアプリを作った

作ったもの

カメラを向けると、信号が青か赤か判定するアプリ

実機テスト風景↓(めちゃ重い)

信号を赤なら赤線、青なら青線、点滅中は黒線で囲う。

ざっくり処理の流れ

判定APIをpythonで自作して、swiftで毎秒画像をpostする感じ。

レスポンスは、信号の色と枠線付きの画像を返す。aws rekognitionで信号を読み取り、openCVで信号切り取り&色の識別

信号と同じ色の枠線をPILで引く

APIコード

from PIL import Image, ImageDraw import boto3 import cv2 import numpy as np import json import io import base64 from flask import Flask, request, jsonify, make_response, send_file, Response app = Flask(__name__) #信号の色を判定。 def __color_dicision(image): hsv = cv2.cvtColor(image, cv2.COLOR_BGR2HSV_FULL) h = hsv[:, :, 0] s = hsv[:, :, 1] v = hsv[:, :, 2] mask = np.zeros(h.shape, dtype=np.uint8) mask[((45 < h) & (h < 60)) & (s > 150) & (v > 90)] = 60 mask[((h < 8) | (h > 160)) & (s > 150) & (v > 94)] = 255 color_list = [j for i in mask.tolist() for j in i] if color_list.count(255) > 20: return "red" elif color_list.count(60) > 20: return "blue" else: return "black" #信号に枠線を引く def __draw_border(photo, left_coordinate, top_coordinate, width, height, color_dicision): if color_dicision == "red": fill = (225, 0, 0) if color_dicision == "blue": fill = (100, 225, 100) if color_dicision == "black": fill = (0, 0, 0) draw = ImageDraw.Draw(photo) draw.line((left_coordinate, top_coordinate, left_coordinate + width, top_coordinate), fill=fill, width=8) draw.line((left_coordinate, top_coordinate, left_coordinate, top_coordinate + height), fill=fill, width=8) draw.line((left_coordinate, top_coordinate + height, left_coordinate + width, top_coordinate + height), fill=fill, width=8) draw.line((left_coordinate + width, top_coordinate, left_coordinate + width, top_coordinate + height), fill=fill, width=8) return photo @app.route('/', methods=['GET', 'POST']) def dicision(): if request.files['image']: image = request.files['image'] client = boto3.client('rekognition') #aws rekognitionへpost response = client.detect_labels(Image={'Bytes': image.read()}) #画面に写っている物体の名前と位置が返ってくる for label in response['Labels']: if label['Name'] == "Traffic Light" and label['Confidence'] > 50 and label['Instances'] != []: res = label['Instances'][0]['BoundingBox'] image = Image.open(image) #なぜか上の処理で画像が90度回転するので、直す。 image = image.rotate(270, expand=True) im_size_width, im_size_height = image.size left_coordinate = res["Left"] * im_size_width top_coordinate = res["Top"] * im_size_height width = res["Width"] * im_size_width height = res["Height"] * im_size_height #信号のある箇所をくり抜く im_crop = image.crop( (left_coordinate, top_coordinate, left_coordinate + width, top_coordinate + height)) im_cv = np.asarray(im_crop) color_dicision = __color_dicision(im_cv) drawed_image = __draw_border( image, left_coordinate, top_coordinate, width, height, color_dicision) imgByteArr = io.BytesIO() drawed_image.save(imgByteArr, format='JPEG') imgByteArr = imgByteArr.getvalue() imageStr = base64.b64encode(imgByteArr).decode("utf-8") return jsonify({'result': color_dicision, 'image': imageStr}) print("何もなし") return jsonify({'result': 'no_signal', 'image': ''}) if __name__ == '__main__': app.run(host='0.0.0.0')swift サイドは↓を参考に、Alamofire+codableで実装

https://qiita.com/shirahama_x/items/421d0d343d9629e66794

- 投稿日:2019-07-01T19:52:16+09:00

pandas.DataFrameのMECEな分割で気をつけること

pandas.DataFrameを使ってアルゴリズムを実装する中で、DataFrameをMECEに分割できていないためにバグることが多々あります。

普通のif~else分岐であれば条件はほぼMECEになりますが、DataFrameの分割になると忘れがちな気がしています。(自分だけ?)

そんなとき、DataFrameでも~を使ってelse条件を書くことで、MECE分割されないことによるエラーを防ぐことができます。サンプルとしてKaggleのtitanicデータを使用します。

https://www.kaggle.com/c/titanic/dataimport pandas as pd # データセットの読み込み train = pd.read_csv('../input/train.csv') # 男性かつ20歳以上でDataFrameを分割 train_subset01 = train[ (train['Sex'] == 'male') & (train['Age'] >= 20) ] # not(男性かつ20歳以上)でDataFrameを分割 train_subset02 = train[ ~((train['Sex'] == 'male') & (train['Age'] >= 20)) ] # 分割結果がMECEであることを確認 print(f'total size is :{str(len(train))}') print(f'subset01 size is :{str(len(train_subset01))}') print(f'train_subset02 size is :{str(len(train_subset02))}') print(f'intersection size is :{str(len(set(train_subset01.PassengerId).intersection(set(train_subset02.PassengerId))))}')total size is :891 subset01 size is :364 train_subset02 size is :527 intersection size is :0冗長な表現になりますが、

~を使うことでif~elseを実現できるので、DataFrame分割でミスるリスクを減らせると思います。

- 投稿日:2019-07-01T19:05:34+09:00

量子アルゴリズムの基本:算術演算の確認(剰余加算)

$$

\def\bra#1{\mathinner{\left\langle{#1}\right|}}

\def\ket#1{\mathinner{\left|{#1}\right\rangle}}

\def\braket#1#2{\mathinner{\left\langle{#1}\middle|#2\right\rangle}}

$$はじめに

前回に引き続き、算術演算シリーズです。今回は「剰余加算」です。アルゴリズムを説明した後、自作の量子計算シミュレータqlazyで、動作の確認をします。

参考にさせていただいた論文・記事は以下です。

- V. Vedral,A. Barenco,A. Ekert; "Quantum Networks for Elementary Arithmetic Operations" (arXiv:quant-ph/9511018)

- 量子コンピュータ(シミュレータ)でモジュロ加算器を作る(@converghub)

- 量子コンピュータ(シミュレータ)でモジュロ加算器を作る【QISKit編】(@converghub)

剰余加算の実現方法

参考論文に全体の回路図が出ているので、まずそれを掲載します。

論文には、

\ket{a,b} \rightarrow \ket{a,a+b \space mod \space N}を計算する回路と説明されています(ただし、$0 \leqq a,b < N$です)。これで本当に剰余加算が実現できるのでしょうか。図を参照しながら1ステップずつ見ていきます。

まずはじめに、$a,b,N$用のレジスタおよび補助的なレジスタを用意します。図の左側に「$a,b,N,0$」と記号が書かれています。各々何ビットのレジスタにするかは、注意深く決める必要があります。適当に決めてしまうと、入力の値によって途中の計算でオーバーフローしておかしな結果を出してしまう可能性があるからです(言うまでもないことですが)。$a,b$は加算する値で、その結果は$b$のレジスタ(以後、レジスタ<b>と書くことにします)に入りますので、$b$のビット数は$a$よりも1つ多くしておく必要があります。また、今回の前提は、$0 \leqq a,b < N$だったので、$N$のビット数は計算したいビット数よりも1つ多くしておく必要があります。さらに、後で説明するようにレジスタ<a>とレジスタ<N>は途中スワップさせますので、同じビット数にしておいた方が良いです。ということを、すべて合わせて考慮すると、計算したいビット数$n$に対して、レジスタ<a>には$n+1$ビット、レジスタ<b>には$n+2$ビット、レジスタ<N>には$n+1$ビットを割り当てておけば良いことになります。それから図には明示的に記載されていないのですが、ADDERを実現するためには、前回の記事で説明したように、桁上げ情報を格納しておくためのレジスタ<c>も必要です。レジスタ<b>と同じ数の量子ビットを用意しておいて最上位ビットは<c>と共有しますので、さらに追加で$n+1$ビット必要になります論文には、このあたり逐一説明されていないのですが、そういうことになるのかなと思っています。間違っていたらご指摘ください)。この考え方に基づくと、結局、$n$ビット同士の剰余加算を実行するためには、$(n+1)+(n+2)+(n+1)+(n+1)+1=4n+6$ビット必要になります。

さて、それでは実際の量子計算について見ていきます。図中の番号(1)から(10)に至るまで、状態がどう変化するかを以下の表に示しました。ここで、上の行から順番にレジスタ<a>,<b>,<N>,<t>の状態を表しています(<t>は図中一番下の補助量子ビットを表しています)。また、この表は状態の変化を表しているので、ケット記号を使って、例えば$\ket{a}$等と書くべきなのですが、面倒なので単に$a$とのみ書くことにしました。

初期状態 (1) (2) (3) (4) (5) (6) (7) (8) (9) (10) $a$ $a$ $N$ $N$ [↑]$0$

[↓]$N$[↑]$0$

[↓]$N$$N$ $a$ $a$ $a$ $a$ $b$ $a+b$ $a+b$ $a+b-N$ [↑]$a+b-N$

[↓]$a+b-N$[↑]$a+b-N$

[↓]$a+b$[↑]$a+b-N$

[↓]$a+b$[↑]$a+b-N$

[↓]$a+b$[↑]$b-N$

[↓]$b$[↑]$b-N$

[↓]$b$[↑]$a+b-N$

[↓]$a+b$$N$ $N$ $a$ $a$ $a$ $a$ $a$ $N$ $N$ $N$ $N$ $t=0$ $0$ $0$ $0$ [↑]$1$

[↓]$0$[↑]$1$

[↓]$0$[↑]$1$

[↓]$0$[↑]$1$

[↓]$0$[↑]$1$

[↓]$0$$0$ $0$ まず、(1)は、単なるADDERなので、レジスタ<b>に$a+b$が入るだけです。

(2)は、レジスタ<a>とレジスタ<N>のスワップです。$a$と$N$が入れ替わります。

(3)は、ADDERの逆(引き算)です。レジスタ<b>の値$a+b$からレジスタ<a>の値$N$を引いたもの、すなわち$a+b-N$が、レジスタ<b>に入ります。ここで、$a+b$と$N$の大小関係によって、レジスタ<b>の最上位ビットが1になるか0になるかが変わります。$a+b-N$が負の数になる場合、アンダーフロー状態となり、レジスタ<b>の最上位ビットは1になります。そうでない場合は0です。以後、どっちのパターンかによって、場合分けして考えていきます。

(4)は、2つのことを行っています。まず、レジスタ<b>に対する操作についてです。レジスタ<b>の最上位ビットが0だった場合(つまり、$a+b \geqq N$)、レジスタ<t>が1に変化し、そうでない場合(つまり、$a+b < N$)、レジスタは0のままです。表の中で、[↑]と記載したのは$a+b \geqq N$の場合、[↓]と記載したのは、$a+b < N$の場合です。次に、レジスタ<a>に対する操作についてです。ここで、レジスタ<a>に矢印がささったような制御ユニタリ系のちょっと見かけない記号が出てきました。論文によると、制御ビット(レジスタ)が1の場合、レジスタ<b>を$\ket{0}$にし、そうでない場合そのまま何もしない演算子とのことです(ここでは、「アロー演算子」と呼ぶことにします)。結局、$a+b \geqq N$の場合([↑])、レジスタ<a>は$0$、レジスタ<b>は$a+b-N$(アンダーフローなし)、$a+b < N$の場合([↓])、レジスタ<a>は$N$、レジスタ<b>は$a+b-N$(アンダーフローあり)となります。

(5)は、単なるADDERです。[↑]/[↓]の場合分けによって、レジスタ<b>が異なる変化をします。[↑]の場合、$0$を足すので、$a+b-N$のまま、[↓]の場合、$N$を足すので、アンダーフロー状態が解消されて、$a+b$となります。

(6)は、レジスタ<a>に対するアロー演算子です。レジスタ<t>の制御ビットがどっちであったとしても、レジスタ<a>には$N$が入ることになります。

(7)は、単なるスワップです。レジスタ<a>とレジスタ<N>の値が入れ替わります。

(8)は、逆ADDER(引き算)です。ちょっとトリッキーなのですが、これの意図はレジスタ<t>を$0$に戻すことです。レジスタ<b>から$a$を引くことで、[↑]$b-N$、[↓]$b$となります。すると、[↑]の場合、レジスタ<b>はアンダーフロー状態になり、最上位ビットに1が立ちます。[↓]の場合、最上位ビットは0のままです。この状態にしておいて、次のステップに行きます。

(9)は、レジスタ<b>の最上位ビットによって、レジスタ<t>の状態が変わる回路です。前段でのレジスタ<b>の最上位ビットが1の場合のみ、Xゲートが働くので、レジスタ<t>の値は0に戻ることになります。

(10)は、ADDERです。(8)(9)でトリッキーなことをやったので、レジスタ<b>をもとに戻します。[↑]の場合、$a+b-N$、[↓]の場合、$a+b$となります。これで、$a+b \space mod \space N$が実現できたことになります。

シミュレータで動作確認

さて、それではシミュレータで、この剰余加算の動作を確認してみます。今回想定したのは、3ビット同士の剰余加算です。具体的には、b=5,N=9を固定にして、aを取りうる値すべて(0,1,2,...,7)の重ね合わせとして、一気に剰余加算をやってみます。全体のPythonコードは以下の通りです。

from qlazypy import QState def swap(self,id_0,id_1): dim = min(len(id_0),len(id_1)) for i in range(dim): self.cx(id_0[i],id_1[i]).cx(id_1[i],id_0[i]).cx(id_0[i],id_1[i]) return self def sum(self,q0,q1,q2): self.cx(q1,q2).cx(q0,q2) return self def i_sum(self,q0,q1,q2): self.cx(q0,q2).cx(q1,q2) return self def carry(self,q0,q1,q2,q3): self.ccx(q1,q2,q3).cx(q1,q2).ccx(q0,q2,q3) return self def i_carry(self,q0,q1,q2,q3): self.ccx(q0,q2,q3).cx(q1,q2).ccx(q1,q2,q3) return self def plain_adder(self,id_a,id_b,id_c): depth = len(id_a) for i in range(depth): self.carry(id_c[i],id_a[i],id_b[i],id_c[i+1]) self.cx(id_a[depth-1],id_b[depth-1]) self.sum(id_c[depth-1],id_a[depth-1],id_b[depth-1]) for i in reversed(range(depth-1)): self.i_carry(id_c[i],id_a[i],id_b[i],id_c[i+1]) self.sum(id_c[i],id_a[i],id_b[i]) return self def i_plain_adder(self,id_a,id_b,id_c): depth = len(id_a) for i in range(depth-1): self.i_sum(id_c[i],id_a[i],id_b[i]) self.carry(id_c[i],id_a[i],id_b[i],id_c[i+1]) self.i_sum(id_c[depth-1],id_a[depth-1],id_b[depth-1]) self.cx(id_a[depth-1],id_b[depth-1]) for i in reversed(range(depth)): self.i_carry(id_c[i],id_a[i],id_b[i],id_c[i+1]) return self def arrow(self,N,q,id): for i in range(len(id)): if (N>>i)%2 == 1: self.cx(q,id[i]) return self def modular_adder(self,N,id_a,id_b,id_c,id_N,id_t): self.plain_adder(id_a,id_b,id_c) self.swap(id_a,id_N) self.i_plain_adder(id_a,id_b,id_c) self.x(id_b[len(id_b)-1]) self.cx(id_b[len(id_b)-1],id_t[0]) self.x(id_b[len(id_b)-1]) self.arrow(N,id_t[0],id_a) self.plain_adder(id_a,id_b,id_c) self.arrow(N,id_t[0],id_a) self.swap(id_a,id_N) self.i_plain_adder(id_a,id_b,id_c) self.cx(id_b[len(id_b)-1],id_t[0]) self.plain_adder(id_a,id_b,id_c) return self def encode(self,decimal,id): for i in range(len(id)): if (decimal>>i)%2 == 1: self.x(id[i]) return self def create_register(digits): num = 0 id_a = [i for i in range(digits+1)] num += len(id_a) id_b = [i+num for i in range(digits+2)] num += len(id_b) id_c = [i+num for i in range(digits+2)] id_c[digits+1] = id_b[digits+1] # share the qubit id's num += (len(id_c)-1) id_N = [i+num for i in range(digits+1)] num += len(id_N) id_t = [i+num for i in range(1)] num += len(id_t) id_r = id_b[:-1] # to store the result return (num,id_a,id_b,id_c,id_N,id_t,id_r) def superposition(self,id): for i in range(len(id)-1): self.h(id[i]) return self def result(self,id_a,id_b): # measurement id_ab = id_a + id_b iid_ab = id_ab[::-1] freq = self.m(id=iid_ab).frq # set results a_list = [] r_list = [] for i in range(len(freq)): if freq[i] > 0: a_list.append(i%(2**len(id_a))) r_list.append(i>>len(id_a)) return (a_list,r_list) if __name__ == '__main__': # add methods QState.swap = swap QState.sum = sum QState.i_sum = i_sum QState.carry = carry QState.i_carry = i_carry QState.arrow = arrow QState.plain_adder = plain_adder QState.i_plain_adder = i_plain_adder QState.modular_adder = modular_adder QState.encode = encode QState.superposition = superposition QState.result = result # create registers digits = 3 num,id_a,id_b,id_c,id_N,id_t,id_r = create_register(digits) # set iput numbers b = 5 N = 9 # initialize quantum state qs = QState(num) qs.superposition(id_a) # set superposition of |0>,|1>,..,|7> for |a> qs.encode(b,id_b) qs.encode(N,id_N) # execute modular adder qs.modular_adder(N,id_a,id_b,id_c,id_N,id_t) a_list,r_list = qs.result(id_a,id_r) for i in range(len(a_list)): print("{0:}+{1:} mod {2:} -> {3:}".format(a_list[i],b,N,r_list[i])) qs.free()何をやっているか順に説明します。

def swap(self,id_0,id_1): dim = min(len(id_0),len(id_1)) for i in range(dim): self.cx(id_0[i],id_1[i]).cx(id_1[i],id_0[i]).cx(id_0[i],id_1[i]) return selfは、2つのレジスタのスワップです。swapゲートを対象となる量子ビット数分繰り返しています。

def i_plain_adder(self,id_a,id_b,id_c): depth = len(id_a) for i in range(depth-1): self.i_sum(id_c[i],id_a[i],id_b[i]) self.carry(id_c[i],id_a[i],id_b[i],id_c[i+1]) self.i_sum(id_c[depth-1],id_a[depth-1],id_b[depth-1]) self.cx(id_a[depth-1],id_b[depth-1]) for i in reversed(range(depth)): self.i_carry(id_c[i],id_a[i],id_b[i],id_c[i+1]) return selfで、ADDERの逆演算を定義しています。関数plain_adderの処理を逆に実施しているだけです。

def arrow(self,N,q,id): for i in range(len(id)): if (N>>i)%2 == 1: self.cx(q,id[i]) return selfで、アロー演算子を定義しています。実は、この実装をどうすればよいか、ちょっと悩みました。@converghubさんの記事では、Nの値を格納しておくための補助量子ビットを追加で用意した上で、Toffoliゲートを複数使って、実現されていました。が、論文には、複数のCNOTゲートで実現できると書いてあるので、補助量子ビットなしで何とかなるんだろと思い、考えてみました。結局、Nはこの量子計算を行うにあたり、はじめから与えられている値なので、Nのビット配列のどこに1が立っているのかを見て、CNOTゲートのターゲットとなる量子ビット番号を決めて、それを複数適切に並べれば良いということに思い至りました。それを上のように実装してみました。

def modular_adder(self,N,id_a,id_b,id_c,id_N,id_t): self.plain_adder(id_a,id_b,id_c) self.swap(id_a,id_N) self.i_plain_adder(id_a,id_b,id_c) self.x(id_b[len(id_b)-1]) self.cx(id_b[len(id_b)-1],id_t[0]) self.x(id_b[len(id_b)-1]) self.arrow(N,id_t[0],id_a) self.plain_adder(id_a,id_b,id_c) self.arrow(N,id_t[0],id_a) self.swap(id_a,id_N) self.i_plain_adder(id_a,id_b,id_c) self.cx(id_b[len(id_b)-1],id_t[0]) self.plain_adder(id_a,id_b,id_c) return selfで、剰余加算を定義しています。最初に示した回路図をそのまま実現しています。

その他の関数sum、i_sum、carry、i_carry、plain_adder、encode、superposition、resultについては、前回の記事で説明したので、省略します。関数create_registerは、前回と実装が違っていますが、今回の計算に合わせてレジスタを用意するものです。こちらも説明省略します。

というわけで、プログラム本体の説明です。

# create registers digits = 3 num,id_a,id_b,id_c,id_N,id_t,id_r = create_register(digits)レジスタ<a>,<b>,<N>,<t>、ADDERで必要になる桁上げ用補助レジスタ<c>、剰余加算のための補助レジスタ<t>、および結果を取得するレジスタ<r>(=測定するレジスタ=レジスタ<b>)を決め、全体で必要になる量子ビット数も合わせて出力し、各変数に格納しておきます。

# set iput numbers b = 5 N = 9 # initialize quantum state qs = QState(num) qs.superposition(id_a) # set superposition of |0>,|1>,..,|7> for |a> qs.encode(b,id_b) qs.encode(N,id_N)今回、固定入力するb,Nの値を設定し、aについては取りうる値すべての重ね合わせ状態とします。

# execute modular adder qs.modular_adder(N,id_a,id_b,id_c,id_N,id_t)剰余加算を実行します。

a_list,r_list = qs.result(id_a,id_r) for i in range(len(a_list)): print("{0:}+{1:} mod {2:} -> {3:}".format(a_list[i],b,N,r_list[i]))測定によって得られた結果から、レジスタ<a>の状態とレジスタ<r>(=レジスタ<b>)の状態をセットにして表示します。

実行結果は、以下の通りです。

4+5 mod 9 -> 0 5+5 mod 9 -> 1 6+5 mod 9 -> 2 7+5 mod 9 -> 3 0+5 mod 9 -> 5 1+5 mod 9 -> 6 2+5 mod 9 -> 7 3+5 mod 9 -> 8というわけで、剰余加算が正しくできることが確認できました。

おわりに

前回「加算」、今回「剰余加算」が確認できましたので、次回は「制御剰余乗算」(論文には"Controlled-multiplier modulo N"と書いてありましたが、日本語これでいい?)に挑戦です。いままでの回路を部品にして、組み合わせていくようなので、だんだん量子ビット数的に厳しくなっていく予感がありますが、できる範囲で頑張ってみたいと思います。

以上

- 投稿日:2019-07-01T18:31:58+09:00

ACL Anthologyの論文一括DLスクリプト書いた

注:小ネタです。

やったこと

ACL Anthologyの論文pdfを一括DLするスクリプトを書きました.

NAACL2019の論文収集する時に「個別PDF欲しいけどひとつずつDLするのめんどくちゃい」と思ってしまったのでついうっかり書いてしまった.

依存ソフトウェア

- Python3

- Google Chrome

- chromedriver

- chromedriver_binary

- selenium

使い方

python ./acl_anthology_downloader.py -e <event_name> -y <year> -o <output_dir> -d </path/to/chromedriver>イベント名と年度を指定すると該当イベントのpdfをすべてDLする仕様になってます.

例

python ./acl_anthology_downloader.py -e NAACL -y 2019 -o papers/NAACL2019 -d /usr/local/bin/chromedriver注意点

- Selenium+chromedriverを使っているので,Chromeのバージョンと合ったchromedriverをインストールしてください

- デフォルトだとheadlessモードで動作しますが,Linux環境などでheadlessでうまく動作しない場合は

--xvfb/-xオプションを付与してください(当方のWSL環境だとこの状況になりました)実装に関して

今までPythonでのスクレイピングはscrapyを愛用してきましたが,Seleniumにも慣れておきたい意図で今回はSelenium+chromedriverを使用しました.

chromedriverの動作環境構築のコストはかかりますが,APIはscrapyよりかなり使いやすい気がしますね.

Webアプリの自動テストにも使えるし(というか本来の用途はそちら)おわりに

ICMLとかNIPSのダウンローダも書いておきたい.

- 投稿日:2019-07-01T17:47:57+09:00

【Python】?ラーメン屋の食べログ評価を口コミから予測してみた。?

1.簡単な概要

この記事では、ラーメン屋の食べログ評価を口コミから予測するために、取り組んだことを書きます。

ユーザーの口コミから食べログ評価の予測ができれば、仮に食べログに掲載されていないお店があったときに、口コミさえあれば、食べログ換算するとざっくり○点ぐらいだろうことがわかれば嬉しいなと思いやってみました。

今回は、「お店の評価」ではなく、「ユーザーが付けた評価」を当てにいきます!まずは、口コミデータの取得から。

2.口コミデータの取得

詳しくはこちら↓↓で説明しています。

第1弾:【Python】ラーメンガチ勢によるガチ勢のための食べログスクレイピング口コミを1件ずつ取得した後に、データフレームにまとめました。

※食べログ規約にもとづき口コミに関する箇所にはモザイクをいれております。ご了承ください。

3.仮説

口コミにおいて、どのような口コミが点数が高くなるか、ないし低くなるかを仮説を立ててみます。

高評価の口コミ

・口コミの文章量が多い。

・「美味しい」や「絶妙」などラーメンを賞賛する単語が多い

・「丁寧」「感じが良い」など店員のサービスを賞賛する単語が多い低評価の口コミ

・口コミの文章量が少ない

・不味い、普通、微妙等、ネガティブな単語が多い4.基礎分析

取得した口コミ数と口コミ評価の出現頻度です。

また、お店の評価と個々のユーザーの評価の平均値や中央値等も見てみます。import numpy as np import matplotlib as plt #点数がない口コミを除去 df2 = df[df.Individual_rating_score != '-'] #ユニーク店舗数 print('ユニーク店舗数は'+str(df2["store_name"].nunique())+'件') #口コミ数 print('口コミ数は'+str(len(df2))+'件') #出現頻度をプロット vc = df2['Individual_rating_score'].value_counts().reset_index().sort_values('index', ascending=False) vc.plot.bar(x='index', y='Individual_rating_score')df2['score'].describe() df2['Individual_rating_score'].astype(np.float).describe()今回は都内食べログランキングの上から1016店舗から21811件の口コミを取得しました。

数字が中途半端なのはスクレイピングの都合です。

食べログ評価上位(3.5〜4.1)のお店の口コミをスクレイピングしたため、ユーザーの評価も3.5以上に偏っていますね。つまり、割と点数が高めの学習データなので、予測する際にその影響を受けることは念頭におきながら進めます。

5.特徴量の選定(その1)

口コミデータからどうしたら食べログ評価を予測できるか調べるために、点数に効きそうなことを要素を探します。

①口コミの長さとの相関

②感情スコアとの相関感情スコアとは、例えば、「美味しい」、「良い」などpositiveなワードには正の値,「不味い」、「悪い」などはnegativeなワードには負の値を与えスコア化します。このスコアは-1〜+1の範囲ですが「単語感情極性対応表」によって規定されています。

詳しくはこちら↓

http://www.lr.pi.titech.ac.jp/~takamura/pndic_ja.html

https://ohke.hateblo.jp/entry/2017/10/27/230000①口コミの長さとの相関

私の経験則ですが、美味しかったお店の口コミを書くときは、意気揚々として長文になります。

一方で微妙だったお店の口コミ短く済ませてしまうことの多いので、口コミの長さはある程度は関係していると思われます。# sklearn.linear_model.LinearRegression クラスを読み込み from sklearn import linear_model # matplotlib パッケージを読み込み import matplotlib.pyplot as plt # カラムに文字数を追加します。 df2['word_cnt'] = df2['review'].apply(lambda x : len(x)) # 線形回帰モデル clf = linear_model.LinearRegression() # 説明変数に "word_cnt (文字数)" を利用 X = df2.loc[:, ['word_cnt']].as_matrix() # 目的変数に "Individual_rating_score (ユーザー評価)" を利用 Y = df2['Individual_rating_score'].as_matrix() # 予測モデルを作成 clf.fit(X, Y) # 回帰係数 print('回帰係数:'+str(clf.coef_[0])) # 切片 (誤差) print('切片:'+str(clf.intercept_)) # 決定係数 print('決定係数:'+str(clf.score(X, Y))) # 相関係数 corr = np.corrcoef(df2['word_cnt'], df2['Individual_rating_score']) print('相関係数:'+str(corr[1][0])) # Figureを設定 fig = plt.figure() # Axesを追加 ax = fig.add_subplot(111) ax.set_ylim(1, 5) # 散布図 plt.scatter(X, Y) # 回帰直線 plt.plot(X, clf.predict(X))相関係数0.079・・・ということで相関はかなり弱いということがわかりました。当然ですが、口コミの文字数だけで点数が決まるほど単純な話ではありませんでした。

②感情スコアとの相関

感情スコアは-1~+1の範囲で表しますので、口コミにpositiveな単語が多ければ多いほどユーザーが付けた評価も高くなりそうですよね!

f = open('../work/kanjo_dict.txt', 'r') kanjo_dict = {} for line in f: kanjo_list = line.replace('\n','').split(":") kanji = kanjo_list[0] kanjo_dict[kanji] = kanjo_list[3] f.close() kanjo_dictimport MeCab tagger = MeCab.Tagger('-Owakati -d /usr/local/lib/mecab/dic/mecab-ipadic-neologd')#タグはMeCab.Tagger(neologd辞書)を使用 tagger.parse('') # 分かち書きで取得する品詞を指定 def tokenize_ja(text, lower): node = tagger.parseToNode(str(text)) while node: if (lower and node.feature.split(',')[0] in ["名詞","形容詞"]) and lower and node.feature.split(',')[1] !='代名詞': yield node.surface.lower() node = node.next # 分かち書きする関数を定義 def tokenize(content, token_min_len, token_max_len, lower): return [ str(token) for token in tokenize_ja(content, lower) if token_min_len <= len(token) <= token_max_len and not token.startswith('_') ] from statistics import mean #感情スコアを合計する関数を定義 def kanjo_score_total(x): txt = tokenize(x, 1, 10000, True) total = 0 for i in txt: try: total += float(kanjo_dict[i]) except: continue return total #感情スコアを平均する関数を定義 def kanjo_score_avg(x): txt = tokenize(x, 1, 10000, True) score_list =[] for i in txt: try: score_list.append(float(kanjo_dict[i])) except: continue try: mean(score_list) return mean(score_list) except: return np.nan df2['kanjo_score_total'] = df2.review.apply(kanjo_score_total) df2['kanjo_score_avg'] = df2.review.apply(kanjo_score_avg) *プロットする部分のコードは省略なんと、意外なことに「感情スコアの合計」では相関がみられない・・・というかむしろ負になってしまっている。

これは、特徴量としては使えなさそうですね。

次に「感情スコアの平均」は、相関係数0.15ということで弱い相関がみられることがわかりました。

とりあえず「感情スコアの平均」は特徴量の候補に入れます。「感情スコア」を使っても上記のような結果となった要因としては、

①「濃厚」や「淡い」などラーメン用語としてはポジティブそうな単語も「単語感情極性対応表」ではネガティブという判定になっている

②「醤油」や「豚骨」といったポジティブともネガティブとも取れなそうな単語もネガティブになっていたりと、そもそも「単語感情極性対応表」があてにならないケースが多くありました。6.特徴量の選定(その2)

・口コミ出現した全単語をOne-Hotベクトルで表し、corr(相関係数)で寄与度を確認

例えば、単純に「美味しい」という単語が口コミにあったら、その単語が点数に寄与しているか調べます。まずは、出現する単語全てに対して点数と相関があるか調べてみました。# 口コミを分かち書き for i in df2['review']: txt = tokenize(i, 2, 10000, True) wakati_ramen_text.append(txt) # 分かち書きされた単語リストをカラムに追加 df2['wakati_ramen_text'] = wakati_ramen_text df2_words = df2 # 出現頻度の高い単語に絞る※上位10単語は頻出単語のためstopwordとして除外 target_words = df_cnt2.loc[10:1000,'index'].values.tolist() for add_col in target_words: df2_words[add_col] = df2_words['wakati_ramen_text'].apply(lambda x : 1 if add_col in x else 0) # 不要なカラムを除去。 df3 = df2_words.drop(columns=['Unnamed: 0', 'store_id','store_name','score','ward','review_cnt','review','wakati_ramen_text','moji_cnt']) # 相関係数を算出 corr_mat = df3.corr() # 点数と単語の相関だけに絞る corr_Individual_rating_score = corr_mat.loc['Individual_rating_score',:].reset_index() # 相関係数に閾値を決め、絶対値が大きい単語のみに絞る corr_Individual_rating_score2 = corr_Individual_rating_score[(corr_Individual_rating_score["Individual_rating_score"] > 0.04) | (corr_Individual_rating_score["Individual_rating_score"] < -0.02)].sort_values('Individual_rating_score', ascending=False).reset_index() # 絶対値が大きい単語以外のカラムは除去。 target_columns_list = corr_Individual_rating_score2['index'].values.tolist() columns_list = df3.columns.values.tolist() target_df = df3 for col in columns_list: if col not in target_columns_list: target_df = target_df.drop(columns=col) target_dfcorr_Individual_rating_score.sort_values('Individual_rating_score', ascending=False).reset_index() corr_Individual_rating_score.sort_values('Individual_rating_score', ascending=True).reset_index()相関係数が高い単語と低い単語をみると、ポジティブそうな単語はプラスになり、ネガティブそうな単語はマイナスになっています。肌感覚的に信用できそうなので特徴量候補にします。

全単語を特徴量にしてしまうと変数が限りなく増えてしまうので、出現頻度の高い単語上位1000件に絞り、さらにその中から相関係数の絶対値が大きい単語に絞りました。

点数への寄与度が高い単語数を○○つに絞りましたが、説明変数にする際は、クラスタリングで○個の単語を10個の単語群にグルーピングします。7.特徴量作成(その3)

先ほど分かち書きした単語を使いword2vecで単語をベクトル化します。

その後、クラスタリングをして、各単語を10個にグループ分けします。# word2vecモデル作成 model = word2vec.Word2Vec(wakati_ramen_text, sg=1, size=100, window=5, min_count=5, iter=100, workers=3) #sg(0: CBOW, 1: skip-gram),size(ベクトルの次元数),window(学習に使う前後の単語数),min_count(n回未満登場する単語を破棄),iter(トレーニング反復回数) #参考 https://hironsan.hatenablog.com/entry/clustering-word-vectors from collections import defaultdict from gensim.models.keyedvectors import KeyedVectors from sklearn.cluster import KMeans max_vocab = 30000 vocab = list(model.wv.vocab.keys())[:max_vocab] vectors = [model.wv[word] for word in vocab] #クラスター数はこちらで任意の値を定める n_clusters = 10 kmeans_model = KMeans(n_clusters=n_clusters, verbose=0, random_state=42, n_jobs=-1) kmeans_model.fit(vectors) cluster_labels = kmeans_model.labels_ cluster_to_words = defaultdict(list) for cluster_id, word in zip(cluster_labels, vocab): cluster_to_words[cluster_id].append(word) #参考 https://note.nkmk.me/python-dict-change-key/ #辞書のキー名を変更する関数を定義 def change_dict_key(d, old_key, new_key, default_value=None): d[new_key] = d.pop(old_key, default_value) change_dict_key(cluster_to_words, 0, 'ラーメンの感想に関するするワード') change_dict_key(cluster_to_words, 1, '店内に関するワード') change_dict_key(cluster_to_words, 2, '時系に関するワード') change_dict_key(cluster_to_words, 3, '評判や地理的なワード') change_dict_key(cluster_to_words, 4, 'ネット用語ワード') change_dict_key(cluster_to_words, 5, '券売機や食券に関するワード') change_dict_key(cluster_to_words, 6, '周辺の環境や地理的なワード') change_dict_key(cluster_to_words, 7, '具材に関するワード') change_dict_key(cluster_to_words, 8, 'スープや調味料に関するワード') change_dict_key(cluster_to_words, 9, 'その他ワード') df_dict = pd.DataFrame.from_dict(cluster_to_words, orient="index").T df_dict↑のデータに対して、

df2_over_1000['wakati_ramen_text'] = wakati_ramen_text cluster_list = df_dict.columns.tolist() plus_master_dict = {} minus_master_dict = {} plus_score_list = [] minus_score_list = [] # 単語の相関係数を正の相関と負の相関に分けてグループ内で足し合わせていく for word_list in df2['wakati_ramen_text'].values.tolist(): plus_master_dict = {} minus_master_dict = {} for cl in cluster_list: plus_master_dict[cl] = 0 minus_master_dict[cl] = 0 for word in word_list: try: columns_word = cluster_list[df_dict_pair[word]] if corr_dict[word] >0: plus_master_dict[columns_word] += corr_dict[word] elif corr_dict[word] <0: minus_master_dict[columns_word] += corr_dict[word] else: continue except: continue plus_score_list.append(plus_master_dict) minus_score_list.append(minus_master_dict) df2['kanjo_score_avg'] = df2.review.apply(kanjo_score_avg) df2['plus_score_list'] = plus_score_list df2['minus_score_list'] = minus_score_list for add_col in cluster_list: df2['+'+str(add_col)] = df2_2['plus_score_list'].apply(lambda x : x[add_col]) df2['-'+str(add_col)] = df2_2['minus_score_list'].apply(lambda x : -1*x[add_col]) target_df = df2.drop(columns=['Unnamed: 0', 'store_id','store_name','score','ward','review_cnt','review','plus_score_list','minus_score_list','kanjo_score_avg']) target_df8.重回帰分析

import statsmodels.api as sm X = target_df.drop('Individual_rating_score', 1) X = sm.add_constant(X) Y = target_df['Individual_rating_score'] model = sm.OLS(Y, X) result = model.fit() result.summary()

黄色で示した決定係数(R-Squared)は、回帰式によって説明できる割合を表わします。

そして、決定係数の値は0から1の間で、値が大きいほど分析精度は良いといえます。プラスに効いている説明変数TOP3は、(p値0.5以下)

1位その他のワード

2位評判や行列に関するワード

3位店内に関するワードマイナスに効いている説明変数ワースト3は、(p値0.5以下)

1位店内に関するワード

2位行列や待ち時間に関するワード

3位ラーメンの感想に関するワードこの結果から考察すると、

・評判や行列が点数と高くする要因となっている。(食べる前の印象が大事ということでしょうか)

・店内に関するワードがプラスにもマイナスにも効いているので、店内の雰囲気や接客が良くも悪くも点数に響いている。

・ラーメンの感想はネガティブの場合に点数を低くする。(美味しいのはあたりまえで、そのでないと点数がガクッと下がる)ラーメンの感想に関するワードが、どちらも1位でなかったのが意外でした。

さらに、数値予測問題における精度評価指標の手法であるMAE(Mean Absolute Error)を計算します。

MAEは正解から平均的にどの程度の乖離があるかを示します。

モデルの予測精度の"悪さ"を表すため、0 に近い値であるほど優れています。#MAEを算出 from sklearn.metrics import mean_absolute_error testX = X testX['const'] = 1.0 # 切片を追加 # testX = testX.ix[:,X.columns] # 重回帰式で得られた予測値をテストデータに代入させる pred = result.predict(testX) testX ['pred'] = pred target_df['pred'] = pred y_true = target_df['Individual_rating_score'] y_pred = target_df['pred'] mean_absolute_error(y_true, y_pred)MAE:0.2606560766702907

今回の重回帰分析の結果

決定係数:0.245

MAE:0.260

ということで、お世辞にも「口コミから食べログ評価を予測できました!」とはいえませんね(>_<)

他の手法(決定木やランダムフォレスト)も試してみましたが、大きく改善することがなかったので、口コミデータだけから食べログ評価の予測には限界があるのかもしれません。9.ロジスティック回帰

何かしら成果になる結果を出したかったので、

ロジスティック回帰で、口コミが3.5以上or3.5未満か予測してみました。from sklearn.linear_model import LogisticRegression from sklearn.model_selection import train_test_split from sklearn import metrics from sklearn.metrics import confusion_matrix, accuracy_score, precision_score, recall_score, f1_score target_df['score_class']=target_df['Individual_rating_score'].apply(lambda x : '3.5以上' if x >=3.5 else '3.5未満') X = target_df.drop(['Individual_rating_score','score_class'], 1) X = sm.add_constant(X) Y = target_df['score_class'] logreg = LogisticRegression() # データを分割します。テストが全体の40%になるようにします。 X_train, X_test, Y_train, Y_test = train_test_split(X, Y, test_size=0.4,random_state=None) # データを使って学習します。 result = logreg.fit(X_train, Y_train) # テストデータを予測します。 Y_pred = logreg.predict(X_test) # 精度を計算してみましょう。 print(metrics.accuracy_score(Y_test,Y_pred)) print('confusion matrix = \n', confusion_matrix(y_true=Y_test, y_pred=Y_pred)) print('accuracy = ', accuracy_score(y_true=Y_test, y_pred=Y_pred)) print('precision = ', precision_score(y_true=Y_test, y_pred=Y_pred)) print('recall = ', recall_score(y_true=Y_test, y_pred=Y_pred)) print('f1 score = ', f1_score(y_true=Y_test, y_pred=Y_pred))accuracy = 0.76287932251235

confusion matrix =

[[1010 38]

[ 298 71]]正解率は76.3%でした。

まあまあ良さげな結果になりました!10.結論

口コミから正確に点数を予測することができませんでしたが、ロジスティック回帰のモデルを使えば、食べログに掲載のないお店に対して、ざっくり「3.5以上or3.5未満」かを予測して、一般的に美味しいお店かそうじゃないかを判断することができそうです!

11.課題

口コミは、様々な表現があり特徴量の作成が難しいことがわかりました。

例えば、淡麗系のラーメン屋と濃厚系のラーメン屋では、口コミに使う言葉の表現が異なるので一概に「○○のような口コミなら点数が高い」とは言い切れないのです。

試しに、データセットを醤油ラーメンだけに限定してモデルを作ると精度が良くなりました。

ですので、口コミからスープの種類を判別したのちにスープごとのモデルを作るとより、実用的な予測ができるのではないかと思います。もっとこうしたらいいんじゃないかというアドバイスがありましたら是非コメントしてください!

?本記事が少しでも参考になりましたら是非「いいね」をお願いします!?

- 投稿日:2019-07-01T17:27:38+09:00

[訓練・データ不要]ディープラーニングフレームワークを使ったアニメの線画の自動生成

ディープラーニングのフレームワークを使って、アニメ本編から線画を生成します。ただし、一切訓練や訓練データを与えていません。アニメ1話分全4.3万フレームの線画化を1時間程度で終わらせることができました。

あらまし

このようにアニメ本編から自動的に線画が生成できます。ディープラーニングのフレームワークを使うとできます。ただし、一切訓練をしていません。

OP https://t.co/52t0dFZNZL pic.twitter.com/7aCEJ9SkTc

— しこあん@『モザイク除去本』(技術書典6)好評通販中 (@koshian2) 2019年7月1日本編1 https://t.co/52t0dFZNZL pic.twitter.com/oicU8UPopS

— しこあん@『モザイク除去本』(技術書典6)好評通販中 (@koshian2) 2019年7月1日本編2 https://t.co/52t0dFZNZL pic.twitter.com/K7Y6scHiqK

— しこあん@『モザイク除去本』(技術書典6)好評通販中 (@koshian2) 2019年7月1日元ネタ

そこそこな線画を目指す OpenCV

https://qiita.com/khsk/items/6cf4bae0166e4b12b942こちらの記事のアルゴリズムを使います。もともとはOpenCVの実装ですが、ディープラーニングの関数に変換することができます。

OpenCV→ディープラーニングへの置き換え

OpenCVを使った線画化のアルゴリズムは以下の処理の構成です。

- カラー画像のグレースケール化

- 1の画像を8近傍で膨張処理を1回

- 膨張処理した画像と1の画像の差分の絶対値を取る

- 3の画像の白黒反転させる

膨張処理をどうにかすれば、あとは四則演算や行列積でできそうな気がしますよね。OpenCVのモルフォロジー変換のドキュメントを見ると次の式が書かれていました。

$$dst(x,y)=\max_{(x',y'):\rm{element} (x',y')\neq0}src(x+x',y+y') $$

この式をよく見ると、MaxPoolingっぽくないですか? ただし、普通のMaxPoolingは解像度が下がってしまうので、入力と出力の解像度が変わらないように「pool_size=(3,3), stride=1, padding="same"」という特殊なプーリングを行います(GoogLe NetのInceptionブロックでこういう使い方しています)。

つまり、ディープラーニングの処理でOpenCVの線画化の処理を置き換えると次のようになります。

- カラー画像のグレースケール化 → 行列積 or 1x1畳み込み

- 1の画像を8近傍で膨張処理を1回 → stride=1, padding="same"の3x3 MaxPooling

- 膨張処理した画像と1の画像の差分の絶対値を取る → ただの絶対値+引き算

- 3の画像の白黒反転させる → 1.0-画像

OpenCVの処理を無事にディープラーニングの文脈に置き換えることができました。あとは実装するだけです。

何が美味しいの?

ディープラーニングフレームワークに置き換えてなにが美味しいの?という疑問があるかもしれません。理由はいくつかあります。

- GPUブーストが簡単に使える

OpenCVの処理をGPU上で簡単に行うことができます。KerasならCPUと同じコードでできます。- ディープラーニング上で「線画」の概念が扱える

もともと自分が欲しかったのはこっちで、損失関数内で線画の損失関数を定義したかったのです。この方法なら、カラー画像→線画への変換をディープラーニングのモデル内で行えます。ディープラーニングフレームワークによる実装

元画像

元の記事と同じように「響け!ユーフォニアム」の画像を使います。これを「eupho.jpg」とします。

Keras

Kerasの場合は以下のような処理になります。ディープラーニングのフレームワークでは、画像は4階テンソルとして扱うため前後にテンソル変換を挟んでいます(load_tensor, show_tensor)。

import numpy as np from PIL import Image import keras.backend as K import matplotlib.pyplot as plt def load_tensor(): with Image.open("eupho.jpg") as img: array = np.asarray(img, np.float32) / 255.0 # [0, 1] array = np.expand_dims(array, axis=0) # KerasはNHWC return K.variable(array) def show_tensor(input_image_tensor): img = K.eval(input_image_tensor * 255.0) img = img.astype(np.uint8)[0,:,:,0] plt.imshow(img, cmap="gray") plt.show() def linedraw(): # データの読み込み x = load_tensor() # Y = 0.299R + 0.587G + 0.114B でグレースケール化 gray_kernel = K.variable( np.array([0.299, 0.587, 0.114], np.float32).reshape(3, 1)) x = K.dot(x, gray_kernel) # dot積でOK # 3x3カーネルで膨張1回(膨張はMaxPoolと同じ) dilated = K.pool2d(x, pool_size=(3, 3), strides=(1, 1), padding="same") # 膨張の前後でL1の差分を取る diff = K.abs(x-dilated) # ネガポジ反転 x = 1.0 - diff # 結果表示 show_tensor(x) if __name__ == "__main__": linedraw()うまくいきました。

PyTorch

PyTorchの場合は以下のようになります。グレースケール化で1x1畳み込みを使っているのが違うところです。

import numpy as np from PIL import Image import torch import torch.nn.functional as F import matplotlib.pyplot as plt def load_tensor(): with Image.open("eupho.jpg") as img: array = np.asarray(img, np.float32) / 255.0 # [0, 1] array = np.expand_dims(array, axis=0) array = np.transpose(array, [0, 3, 1, 2]) # PyTorchはNCHW return torch.as_tensor(array) def show_tensor(input_image_tensor): img = input_image_tensor.numpy() * 255.0 img = img.astype(np.uint8)[0,0,:,:] plt.imshow(img, cmap="gray") plt.show() def linedraw(): # データの読み込み x = load_tensor() # Y = 0.299R + 0.587G + 0.114B でグレースケール化 gray_kernel = torch.as_tensor( np.array([0.299, 0.587, 0.114], np.float32).reshape(1, 3, 1, 1)) x = F.conv2d(x, gray_kernel) # 行列積は畳み込み関数でOK # 3x3カーネルで膨張1回(膨張はMaxPoolと同じ) dilated = F.max_pool2d(x, kernel_size=3, stride=1, padding=1) # 膨張の前後でL1の差分を取る diff = torch.abs(x-dilated) # ネガポジ反転 x = 1.0 - diff # 結果表示 show_tensor(x) if __name__ == "__main__": linedraw()ディープラーニングなのに訓練/データ不要

このアルゴリズムの面白いところなのですが、ディープラーニングなのに学習する係数が1個もありません。したがって、モデルを定義をした段階で訓練フェーズをすっ飛ばしてすぐ使うことができます。

アニメ1話分を全て線画に変換してみよう

応用例として、YouTubeにあるアニメ1話分を丸々線画に変換して、Before-Afterで動画として保存します。以下の流れで行います。

- YouTubeからPyTubeで動画をダウンロード

- フレーム単位で静止画(カラー画像)で切り出し

- Kerasでカラー画像を全て線画に変換

- もとのカラー画像と線画を組み合わせて動画として再エンコード

今回はKerasを使っていますが、PyTorchや他のフレームワークでもできます。暇な方はやってみてはいかがでしょうか。

ちなみにColabでやる場合はYouTubeの再生地域制限に引っかかるケースがあります。日本から動画が見れてもColabのサーバーがアメリカにあるので、アメリカからの接続と認識されてDLできないケースがあります(その場合は日本のHTTPSプロキシ経由で接続しますが説明は省略します)。ローカルにDLする場合は特に心配しなくてOKです。

必要ライブラリ

ffmpeg

ffmpegはPythonのライブラリの他に、本体のバイナリが必要なので本家から必要なバイナリをダウンロードしておきます。Windowsならffmpegのexeファイルを実行ディレクトリにおきます。

OpenH264

H264でエンコードする際に必要。以下のリポジトリから、H264の1.8.0かつ64ビットのライブラリをOSに応じてダウンロード。同じく実行ディレクトリにおいておきます。

https://github.com/cisco/openh264/releases

その他ライブラリ

pip install ffmpeg-python pip install pytube他にインストールされていないライブラリがあったら適宜pip installでインストールします。

コード

動画はYouTubeの公式配信の侵略!イカ娘の第1話を使っています。

import ffmpeg from pytube import YouTube import os import glob import cv2 import numpy as np from tqdm import tqdm import keras from keras import layers import keras.backend as K from PIL import Image def download_youtube(): if not os.path.exists("video"): os.mkdir("video") yt = YouTube("https://www.youtube.com/watch?v=JUIk6a1nzFw") query = yt.streams.filter(fps=30, subtype="mp4", res="360p").all() query[0].download("video") def extract_images(): if not os.path.exists("images"): os.mkdir("images") stream = ffmpeg.input(glob.glob("video/*")[0]) stream = ffmpeg.output(stream, f"images/frame_%05d.png", f="image2", q=4) ffmpeg.run(stream) def linedraw_func(input_tensor): gray_kernel = K.variable( np.array([0.299, 0.587, 0.114], np.float32).reshape(3, 1)) x = K.dot(input_tensor, gray_kernel) # dot積でOK # 1枚単位でmin-maxスケーリングしてコントラスト補正する mins = K.min(x, axis=(1,2,3), keepdims=True) maxs = K.max(x, axis=(1,2,3), keepdims=True) x = (x-mins) / (maxs-mins+K.epsilon()) dilated = K.pool2d(x, pool_size=(3, 3), strides=(1, 1), padding="same") diff = K.abs(x-dilated) x = 1.0 - diff return x IMG_WIDTH, IMG_HEIGHT = 640, 360 def linedraw_model(): input = layers.Input((IMG_HEIGHT, IMG_WIDTH, 3)) x = layers.Lambda(linedraw_func)(input) return keras.models.Model(input, x) def convert_all(): # KerasのImageDataGeneratorはroot/classes/img という構造なので、 # ルートディレクトリをカレントディレクトリにし、サブディレクトリとして画像のあるディレクトリを1クラスとして指定 # batch_size分の画像を一度に読み込む、シャッフルはしないようにする(連番で読まれる) gen = keras.preprocessing.image.ImageDataGenerator(rescale=1.0/255).flow_from_directory( "./", class_mode=None, classes=["images"], batch_size=256, shuffle=False, target_size=(IMG_HEIGHT, IMG_WIDTH) ) # 出力ディレクトリ if not os.path.exists("images_line"): os.mkdir("images_line") # ファイル数 n_files = len(glob.glob("images/*.png")) # 線画化の操作をモデルとして読み込む model = linedraw_model() cnt = 1 for X in tqdm(gen): out = model.predict_on_batch(X) # 線画化 # ファイルの保存 for i in range(out.shape[0]): img = (out[i,:,:,0]*255.0).astype(np.uint8) with Image.fromarray(img) as img: img.save(f"images_line/frame_{cnt:05}.png") cnt += 1 if cnt > n_files: return def encode(): fourcc = cv2.VideoWriter_fourcc("h", "2", "6", "4") video = cv2.VideoWriter("output.mp4", fourcc, 29.97, (IMG_WIDTH, IMG_HEIGHT*2)) n = len(glob.glob("images/*")) for i in tqdm(range(1, n + 1)): img_original = cv2.imread(f"images/frame_{i:05}.png") img_original = cv2.resize(img_original, (IMG_WIDTH, IMG_HEIGHT), cv2.INTER_LANCZOS4) img_convert = cv2.imread(f"images_line/frame_{i:05}.png") #img_convert = cv2.resize(img_convert, (IMG_WIDTH, IMG_HEIGHT), cv2.INTER_LANCZOS4) x = np.concatenate([img_original, img_convert], axis=0) video.write(x) if __name__ == "__main__": encode()これで生成したのが冒頭の動画。ただし、Twitterの埋め込み動画の画質が悪いので実際はもう少し綺麗に出てたりします1。

生成結果比較

実際の静止画としての出力はこちらになります。カラー画像との比較です。

なかなか良いのではないでしょうか?

速度

ダウンロードからエンコードまでおおよそ1時間程度でした。ffmpegによるフレームの切り出しとストレージがボトルネックになるので、CPU性能とストレージ速度(HDDよりSSD)を上げると高速に出力できます。GPUはほとんど使っていませんでした(使用率でせいぜい5%程度)。もちろんこのあとDeepの訓練につなげる場合は、GPU等のデバイスがあればより高速化できます。

しかし、アニメ1話分の線画が1時間でできてしまうというのはびっくりでした。1話で4.3万フレームあったので(29.97fps × 累計秒)、アニメ本編と既存の画像処理を組み合わせればかなり簡単かつ大量にデータが作れるのかもしれません。

応用 / まとめ

これを使うと、(線画, カラー画)のペアデータが簡単に作れるので2、生成モデルとの相性が良くなります。具体的には、pix2pixなどを使えばアニメの原画~動画の工程をかなり自動化できるのではないでしょうか。

この記事のポイントは、OpenCVで書けるような従来の画像処理も、畳み込みやプーリングといったディープラーニングの操作にある程度置き換えることができるということです。これに気づくとディープラーニングの幅がぐっと広がると思われます。

- 投稿日:2019-07-01T17:00:28+09:00

Google Cloud APIを触ってごにょごにょしてみる(Python編)

概要

Google Cloud APIを使ってアレをナニする必要性に迫られたのでメモ。

何する?

- BigQuery上でのクエリ結果を一時テーブルに保存する

- 一時テーブルの中身をCloud Storageに保存する(JSON形式)

前提条件

- GCPのサービスアカウントに以下の権限が与えられていること

- BigQuery データ編集者

- BigQuery ジョブユーザー

- ストレージのオブジェクト管理者

- サービスアカウントキーの環境変数が設定されていること

export GOOGLE_APPLICATION_CREDENTIALS="/path_to_key/project-xxxxxx.json"仕様

- CUI

- 引数からGCP関連情報(プロジェクト、データセット、テーブル名、バケット名)を取得する。

- BigQueryのクエリを実行し、結果を一時テーブル(tmp_table)に保存する。

- 一時テーブルの内容をJSON形式(改行区切り)でCloud Storageへ保存する。

- 保存先は

gs://backet-name/results.json- ファイル名は

result.jsonで固定とする。実行手順

cd /path_to_source/ python filename.py -p "gcp-project-name" -d "bq-dataset-name" -t "bq-table-name" -b "gcs-backet-name"パラメータ

-p : GCPのプロジェクト名

-d : BigQueryのデータセット名

-t : BigQueryのテーブル名

-b : Cloud Storageのバケット名コードは以下。

#!/usr/bin/env python # -*- coding: utf-8 -* import argparse from google.cloud import bigquery from datetime import datetime def parse(): usage = 'Usage: python {} -p [project] -d [dataset] -t [table] -b [backet] \n \ example: python {} -p "gcp-project-name" -d "bq-dataset-name" -t "bq-table-name" -b "gcs-backet-name"' \ .format(__file__, __file__) # パーサの作成 psr = argparse.ArgumentParser(usage=usage) # for GCP psr.add_argument('-p', '--project', default = 'gcp-project-name') psr.add_argument('-d', '--dataset', default = 'bq-dataset-name') psr.add_argument('-t', '--table', default = 'bq-table-name') psr.add_argument('-b', '--backet', default = 'gcs-backet-name') args = psr.parse_args() print(args) return args class IdcfGcpInfo: def __init__(self, project = 'gcp-project-name', dataset_id = 'bq-dataset-name', table_id = 'bq-table-name', backet_name = 'gcs-backet-name', json_file_name = 'results.json', destination_uri = 'gs://{}/{}', destination_format = 'NEWLINE_DELIMITED_JSON', compression = 'NONE', location = 'asia-northeast1', ): self.project = project self.dataset_id = dataset_id self.table_id = table_id self.backet_name = backet_name self.json_file_name = 'results.json' self.destination_uri = 'gs://{}/{}'.format(self.backet_name, self.json_file_name) self.destination_format = destination_format self.compression = compression self.location = location # BigQuery上で発行するクエリ def query_on_bq(gcp_info): sql = ''' SELECT column1, column2, column3 FROM `{}.{}.{}`;'''.format( gcp_info.project, gcp_info.dataset_id, gcp_info.table_id ) return sql # BigQueryでのクエリ結果を一時テーブルに保存 def save_to_tmp_table_from_query(gcp_info): client = bigquery.Client() job_config = bigquery.QueryJobConfig() # クエリ用configの指定 dataset_ref = client.dataset( dataset_id = gcp_info.dataset_id, project = gcp_info.project ) tmp_ref = dataset_ref.table('tmp_table') # 一時テーブルをセット job_config.destination = tmp_ref # 保存先に一時テーブルを指定 job_config.write_disposition = bigquery.WriteDisposition.WRITE_TRUNCATE # 実行前にTRUNCATEする sql = query_on_bq(gcp_info) # sql取得 # クエリ実行 query_job = client.query(sql, job_config = job_config) query_job.result() # Waits for job to complete. # 一時テーブルの内容をCloud Storageに保存 def save_to_gcs_from_tmp_table(gcp_info): client = bigquery.Client() dataset_ref = client.dataset( dataset_id = gcp_info.dataset_id, project = gcp_info.project ) table_ref = dataset_ref.table(table_id = 'tmp_table') # configの指定 ext_job_config = bigquery.ExtractJobConfig() ext_job_config.destination_format = gcp_info.destination_format ext_job_config.compression = gcp_info.compression # 指定したバケットに保存 extract_job = client.extract_table( source = table_ref, destination_uris = gcp_info.destination_uri, location = gcp_info.location, job_config = ext_job_config ) extract_job.result() # Waits for job to complete. def main(): args = parse() gcp_info = IdcfGcpInfo( project = args.project, dataset_id = args.dataset, table_id = args.table, backet_name = args.backet ) save_to_tmp_table_from_query(gcp_info) save_to_gcs_from_tmp_table(gcp_info) if __name__ == '__main__': main()注意事項

- Cloud StorageのバケットはBigQueryと同じリージョンに配置すること!!

リージョンが異なるともれなくエラーを吐きます。

- Google公式の方法だと、JSON保存形式のオプションに

NEWLINE_DELIMITED_JSONしか指定できません。

デリミタがカンマではなく改行になっています。

こんな感じ

{"ip":"172.26.0.0","time":"2019-01-01 00:00:01","region":"west"} {"ip":"127.0.0.1","time":"2019-01-01 00:30:02","region":"east"} {"ip":"192.168.1.1","time":"2019-01-01 05:30:02","region":"east"}カンマ区切りじゃなきゃヤダ!という場合は、他のエレガントな方法を考える必要があります。

Pythonあまり触ったことがないので、ツッコミどころがあればご指摘いただけると喜びます

- 投稿日:2019-07-01T15:42:19+09:00

pythonでcsvファイルを扱ってみよう

ちょっとCSVファイルを取り扱うことがあったので調べてみました。

モジュールが用意されていて、公式ドキュメントにも使い方が載っています。

csv --- CSV ファイルの読み書きCSVファイルとして次のような内容を想定します。

1列目 2列目 3列目 HOGE FOO BAR 1 2 3 ドキュメントの使用例通り、

with openを使って開いたファイルをcsv.readerで読み込みましょう。動作確認してません.pyimport csv with open('hoge.csv', newline='') as csvfile: rows = csv.reader(csvfile, delimiter=',', quotechar='|') for row in rows: print(row) # ['\ufeffHOGE', 'FOO', 'BAR'] # ['1', '2', '3']以上のように、行一つが配列一つに対応して出力されます。

delimiterパラメータに渡す文字を変更することで、タブ区切りのファイルなども読み込むことができます。ところで気になるのは

\ufeffという謎の文字列。当然ながら、元のCSVファイルには含まれていないものです。

これはBOMと呼ばれる「テキストの始まりをプログラムに伝える」ことを目的とする目印なんだそうですね。

以下のようにエンコードを指定するパラメータを渡してあげると、この余計な文字は読み込まれなくなります。with open('hoge.csv', newline='', encoding='utf-8-sig') as csvfile:参考:\ufeffって???

- 投稿日:2019-07-01T15:24:35+09:00

pythonでスレッドのIDを取得する

何がしたかったのか

既存のソースコードの改修が発端です。

複数回並列で行える処理で最新のスレッドだけが動作するような作りにしたかった。

並列して動くスレッドのIDは別個のものが振られるため、IDを取得できればうまく動かせるのではと考えた。※ その設計がいいとは限らないです。

ちゃんと状態管理してあげるのが正しいんだろうけど

手早く済ませたかったのでこんなやり方をしてます。検証環境

OS: Ubuntu 18.04

python: 3.6.7使うモジュール・関数

- threadingモジュール

- get_ident()

これでスレッドIDは取得できるとのことなので、

後は下のサンプルコードで並行で動いているスレッドがちゃんと別のIDを返してくるかだけ確認するサンプルコード

thread_id_test.pyimport threading as th import time def say_th_id(secouds, th_no): time.sleep(secouds) print("thread no:{0}, ident:{1}".format(th_no, th.get_ident())) if __name__ == "__main__": th1 = th.Thread(target=say_th_id, args=(6,1)) th2 = th.Thread(target=say_th_id, args=(5,2)) th1.start() time.sleep(1.0) th2.start()結果

thread no:1, ident:139790510892800 thread no:2, ident:139790502500096ちゃんと別々のスレッドIDが取得できました。

解釈違いなどあればコメントをください!参考にしたサイト

multithreading - How to find a thread id in Python - Stack Overflow

- 投稿日:2019-07-01T15:17:49+09:00

QGISでPandasを使えるようにする

はじめに

Pandasは便利ですね。

しかしQGISのPythonコンソールからは使えないので使えるようにします。

本当はGeoPandasを入れようとしたのですが、ちょっと解決困難な問題が発生したのでまずはPandasで我慢する。参考にしたサイトはこちら(というか殆どそのまま)

https://umar-yusuf.blogspot.com/2018/12/install-third-party-python-modules-in.htmlモジュールの追加

環境確認

今回はWindows7にQGIS3.4の環境で行ってます。

まずは動作環境を確認します。QGISを立ち上げて、Pythonコンソールを開きましょう。

そしたら以下のコマンドを投げてPandasを読み込めるかどうか試します。

>>> import pandas Traceback (most recent call last): File "C:\PROGRA~1\QGIS3~1.4\apps\Python37\lib\code.py", line 90, in runcode exec(code, self.locals) File "<input>", line 1, in <module> File "C:/PROGRA~1/QGIS3~1.4/apps/qgis-ltr/./python\qgis\utils.py", line 672, in _import mod = _builtin_import(name, globals, locals, fromlist, level) ModuleNotFoundError: No module named 'pandas'はい、モジュールがないよってエラーがでましたね。

出なかったら既に使えるようになっていますので以下の手順は不要です。次にPythonコンソールが使用しているPythonのバージョンを確認します。

以下のようなコマンドを流してください。>>> import sys >>> sys.version '3.7.0 (v3.7.0:1bf9cc5093, Jun 27 2018, 04:59:51) [MSC v.1914 64 bit (AMD64)]'Pythonの3.7.0が使われていることが判りました。

では次にスタートメニューからQGISのフォルダ内にある

OSGeo4W Shellを管理者として実行します。

Windows10の場合はコンテキストメニューの[その他]-「ファイルの場所を開く」してからファイルを選んで管理者として実行ですね。

管理者で実行しないとこの後のインストールでパーミッションが無いって怒られますので注意。OSGeo4W Shellが開いたら

python -Vを投げましょうC:\Windows\System32>python -V Python 2.7.14こちらのPythonは2.7.14が参照されていますね。

pipのインストール

モジュールの追加にはpipをつかいます。

先ほど開いたOSGeo4W Shellを使ってpipをインストールしましょう。

インストールコマンドはpython -m ensurepip --default-pipです。C:\Windows\System32>python -m ensurepip --default-pip Collecting setuptools Requirement already satisfied: pip in c:\progra~1\qgis3~1.4\apps\python27\lib\site-packages Installing collected packages: setuptools Successfully installed setuptools-28.8.0問題なく入りました。

(私の環境にはpipは入ってたようですね)

最新版でないと怒られることがありますのでアップデートも流しておきます。C:\Windows\System32>python -m pip install --upgrade pip setuptools Collecting pip Downloading https://files.pythonhosted.org/packages/5c/e0/be401c003291b56efc55aeba6a80ab790d3d4cece2778288d65323009420/pip-19.1.1-py2.py3-none-any.whl (1.4MB) 100% |################################| 1.4MB 1.6MB/s Collecting setuptools Downloading https://files.pythonhosted.org/packages/ec/51/f45cea425fd5cb0b0380f5b0f048ebc1da5b417e48d304838c02d6288a1e/setuptools-41.0.1-py2.py3-none-any.whl (575kB) 100% |################################| 583kB 2.1MB/s Installing collected packages: pip, setuptools Found existing installation: pip 19.0.3 Uninstalling pip-19.0.3: Successfully uninstalled pip-19.0.3 Found existing installation: setuptools 28.8.0 Uninstalling setuptools-28.8.0: Successfully uninstalled setuptools-28.8.0 Successfully installed pip-19.1.1 setuptools-41.0.1Pythonバージョンの切り替え

OSGeo4W ShellのPythonバージョンが2系でしたので3系に切り替えます。

3系だったら不要だと思います。

OSGeo4W Shellでpy3_envを投げます。

自動的にいくつかSETコマンドが流れます。C:\Windows\System32>py3_env C:\Windows\System32>SET PYTHONPATH= C:\Windows\System32>SET PYTHONHOME=C:\PROGRA~1\QGIS3~1.4\apps\Python37 C:\Windows\System32>PATH C:\PROGRA~1\QGIS3~1.4\apps\Python37;C:\PROGRA~1\QGIS3~1.4\apps\Python37\Scripts;C:\PROGRA~1\QGIS3~1.4\apps\Python27\Scripts;C:\PROGRA~1\QGIS3~1.4\bin;C:\windows\system32;C:\windows;C:\windows\system32\WBem変わったことを確認しましょう。

C:\Windows\System32>python -V Python 3.7.0Pythonコンソールと同じバージョンに変わりました。

Pandasモジュールの追加

pipを使ってPandasを追加しましょう。

OSGeo4W Shellでpython -m pip install pandasと投げます。C:\Windows\System32>python -m pip install pandas Collecting pandas Downloading https://files.pythonhosted.org/packages/61/c7/f943fceb712579bc538700e2c157dc4972e16abfe29bd4969149bad98c74/pandas-0.24.2-cp37-cp37m-win_amd64.whl (9.0MB) 100% |████████████████████████████████| 9.0MB 24kB/s Requirement already satisfied: python-dateutil>=2.5.0 in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from pandas) (2.7.5) Requirement already satisfied: numpy>=1.12.0 in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from pandas) (1.16.3) Requirement already satisfied: pytz>=2011k in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from pandas) (2018.7) Requirement already satisfied: six>=1.5 in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from python-dateutil>=2.5.0->pandas) (1.12.0) Installing collected packages: pandas Successfully installed pandas-0.24.2成功しました。

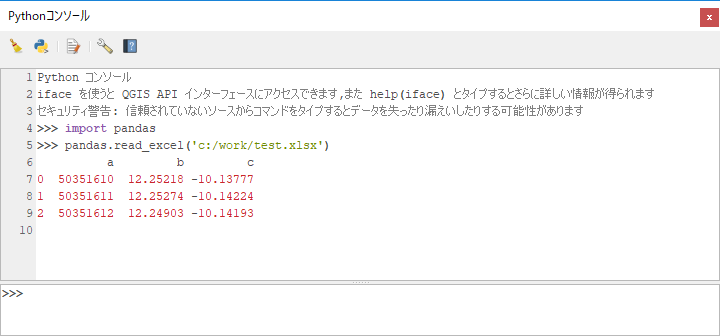

動作確認

では確認してみましょう。

QGISを再起動してから再度Pythonコンソールを開きます。

そしたら先ほどエラーが出たimport pandasを実行してみます。

エラーなくインポートできましたので適当なエクセルファイルでも読み込んでみましょう。>>> import pandas >>> pandas.read_excel('c:/work/test.xlsx') a b c 0 50351610 12.25218 -10.13777 1 50351611 12.25274 -10.14224 2 50351612 12.24903 -10.14193読み込めました。

おまけ:GeoPandasに挑戦

OSGeo4W Shellで

python -m pip install geopandasと投げます。C:\Windows\System32>python -m pip install geopandas Collecting geopandas Downloading https://files.pythonhosted.org/packages/74/42/f4b147fc7920998a42046d0c2e65e61000bc5d104f1f8aec719612cb2fc8/geopandas-0.5.0-py2.py3-none-any.whl (893kB) 100% |████████████████████████████████| 901kB 6.5MB/s Requirement already satisfied: pyproj in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from geopandas) (1.9.6) Requirement already satisfied: shapely in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from geopandas) (1.6.4.post2) Requirement already satisfied: pandas in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from geopandas) (0.24.2) Collecting fiona (from geopandas) Downloading https://files.pythonhosted.org/packages/41/9d/63696e7b1de42aad294d4781199a408bec593d8fdb80a2b4a788c911a33b/Fiona-1.8.6.tar.gz (1.7MB) 100% |████████████████████████████████| 1.7MB 3.1MB/s Complete output from command python setup.py egg_info: A GDAL API version must be specified. Provide a path to gdal-config using a GDAL_CONFIG environment variable or use a GDAL_VERSION environment variable. ---------------------------------------- Command "python setup.py egg_info" failed with error code 1 in C:\Users\hoge\AppData\Local\Temp\pip-install-p0dr78y4\fiona\おっと、エラーがでましたね。

fionaというライブラリがgdal-configへのパスが指定されていないと怒っているようです。同じ問題に困っている人は見つかりますが、簡単には解決しなそうなので一旦あきらめます。

さいごに

今回はPandasを対象としましたが、もちろん他のモジュール追加も可能です。

(GeoPandasは失敗しましたけど)そして、これでプラグインからもPandasが使えるようになります。

ただ公開プラグインには向かないので、何かいい方法があれば教えてもらえたら嬉しいです。本記事のライセンス

この記事は クリエイティブ・コモンズ 表示 4.0 国際 ライセンスの下に提供されています。

- 投稿日:2019-07-01T15:17:49+09:00

QGISでPandasとGeoPandasを使えるようにする

はじめに

Pandas(GeoPandas)は便利ですね。

しかしQGISのPythonコンソールからは使えないので使えるようにします。

本当はGeoPandasを入れようとしたのですが、ちょっと解決困難な問題が発生したのでまずはPandasで我慢する。参考にしたサイトはこちら(というか殆どそのまま)

https://umar-yusuf.blogspot.com/2018/12/install-third-party-python-modules-in.htmlモジュールの追加

環境確認

今回はWindows7にQGIS3.4の環境で行ってます。

まずは動作環境を確認します。QGISを立ち上げて、Pythonコンソールを開きましょう。

そしたら以下のコマンドを投げてPandasを読み込めるかどうか試します。

>>> import pandas Traceback (most recent call last): File "C:\PROGRA~1\QGIS3~1.4\apps\Python37\lib\code.py", line 90, in runcode exec(code, self.locals) File "<input>", line 1, in <module> File "C:/PROGRA~1/QGIS3~1.4/apps/qgis-ltr/./python\qgis\utils.py", line 672, in _import mod = _builtin_import(name, globals, locals, fromlist, level) ModuleNotFoundError: No module named 'pandas'はい、モジュールがないよってエラーがでましたね。

出なかったら既に使えるようになっていますので以下の手順は不要です。次にPythonコンソールが使用しているPythonのバージョンを確認します。

以下のようなコマンドを流してください。>>> import sys >>> sys.version '3.7.0 (v3.7.0:1bf9cc5093, Jun 27 2018, 04:59:51) [MSC v.1914 64 bit (AMD64)]'Pythonの3.7.0が使われていることが判りました。

では次にスタートメニューからQGISのフォルダ内にある

OSGeo4W Shellを管理者として実行します。

Windows10の場合はコンテキストメニューの[その他]-「ファイルの場所を開く」してからファイルを選んで管理者として実行ですね。

管理者で実行しないとこの後のインストールでパーミッションが無いって怒られますので注意。OSGeo4W Shellが開いたら

python -Vを投げましょうC:\Windows\System32>python -V Python 2.7.14こちらのPythonは2.7.14が参照されていますね。

pipのインストール

モジュールの追加にはpipをつかいます。

先ほど開いたOSGeo4W Shellを使ってpipをインストールしましょう。

インストールコマンドはpython -m ensurepip --default-pipです。C:\Windows\System32>python -m ensurepip --default-pip Collecting setuptools Requirement already satisfied: pip in c:\progra~1\qgis3~1.4\apps\python27\lib\site-packages Installing collected packages: setuptools Successfully installed setuptools-28.8.0問題なく入りました。

(私の環境にはpipは入ってたようですね)

最新版でないと怒られることがありますのでアップデートも流しておきます。C:\Windows\System32>python -m pip install --upgrade pip setuptools Collecting pip Downloading https://files.pythonhosted.org/packages/5c/e0/be401c003291b56efc55aeba6a80ab790d3d4cece2778288d65323009420/pip-19.1.1-py2.py3-none-any.whl (1.4MB) 100% |################################| 1.4MB 1.6MB/s Collecting setuptools Downloading https://files.pythonhosted.org/packages/ec/51/f45cea425fd5cb0b0380f5b0f048ebc1da5b417e48d304838c02d6288a1e/setuptools-41.0.1-py2.py3-none-any.whl (575kB) 100% |################################| 583kB 2.1MB/s Installing collected packages: pip, setuptools Found existing installation: pip 19.0.3 Uninstalling pip-19.0.3: Successfully uninstalled pip-19.0.3 Found existing installation: setuptools 28.8.0 Uninstalling setuptools-28.8.0: Successfully uninstalled setuptools-28.8.0 Successfully installed pip-19.1.1 setuptools-41.0.1Pythonバージョンの切り替え

OSGeo4W ShellのPythonバージョンが2系でしたので3系に切り替えます。

3系だったら不要だと思います。

OSGeo4W Shellでpy3_envを投げます。

自動的にいくつかSETコマンドが流れます。C:\Windows\System32>py3_env C:\Windows\System32>SET PYTHONPATH= C:\Windows\System32>SET PYTHONHOME=C:\PROGRA~1\QGIS3~1.4\apps\Python37 C:\Windows\System32>PATH C:\PROGRA~1\QGIS3~1.4\apps\Python37;C:\PROGRA~1\QGIS3~1.4\apps\Python37\Scripts;C:\PROGRA~1\QGIS3~1.4\apps\Python27\Scripts;C:\PROGRA~1\QGIS3~1.4\bin;C:\windows\system32;C:\windows;C:\windows\system32\WBem変わったことを確認しましょう。

C:\Windows\System32>python -V Python 3.7.0Pythonコンソールと同じバージョンに変わりました。

Pandasモジュールの追加

pipを使ってPandasを追加しましょう。

OSGeo4W Shellでpython -m pip install pandasと投げます。C:\Windows\System32>python -m pip install pandas Collecting pandas Downloading https://files.pythonhosted.org/packages/61/c7/f943fceb712579bc538700e2c157dc4972e16abfe29bd4969149bad98c74/pandas-0.24.2-cp37-cp37m-win_amd64.whl (9.0MB) 100% |████████████████████████████████| 9.0MB 24kB/s Requirement already satisfied: python-dateutil>=2.5.0 in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from pandas) (2.7.5) Requirement already satisfied: numpy>=1.12.0 in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from pandas) (1.16.3) Requirement already satisfied: pytz>=2011k in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from pandas) (2018.7) Requirement already satisfied: six>=1.5 in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from python-dateutil>=2.5.0->pandas) (1.12.0) Installing collected packages: pandas Successfully installed pandas-0.24.2成功しました。

動作確認

では確認してみましょう。

QGISを再起動してから再度Pythonコンソールを開きます。

そしたら先ほどエラーが出たimport pandasを実行してみます。

エラーなくインポートできましたので適当なエクセルファイルでも読み込んでみましょう。>>> import pandas >>> pandas.read_excel('c:/work/test.xlsx') a b c 0 50351610 12.25218 -10.13777 1 50351611 12.25274 -10.14224 2 50351612 12.24903 -10.14193読み込めました。

GeoPandasに挑戦

OSGeo4W Shellで

python -m pip install geopandasと投げます。C:\Windows\System32>python -m pip install geopandas Collecting geopandas Downloading https://files.pythonhosted.org/packages/74/42/f4b147fc7920998a42046d0c2e65e61000bc5d104f1f8aec719612cb2fc8/geopandas-0.5.0-py2.py3-none-any.whl (893kB) 100% |████████████████████████████████| 901kB 6.5MB/s Requirement already satisfied: pyproj in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from geopandas) (1.9.6) Requirement already satisfied: shapely in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from geopandas) (1.6.4.post2) Requirement already satisfied: pandas in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from geopandas) (0.24.2) Collecting fiona (from geopandas) Downloading https://files.pythonhosted.org/packages/41/9d/63696e7b1de42aad294d4781199a408bec593d8fdb80a2b4a788c911a33b/Fiona-1.8.6.tar.gz (1.7MB) 100% |████████████████████████████████| 1.7MB 3.1MB/s Complete output from command python setup.py egg_info: A GDAL API version must be specified. Provide a path to gdal-config using a GDAL_CONFIG environment variable or use a GDAL_VERSION environment variable. ---------------------------------------- Command "python setup.py egg_info" failed with error code 1 in C:\Users\hoge\AppData\Local\Temp\pip-install-p0dr78y4\fiona\おっと、エラーがでましたね。

fionaというライブラリがgdal-configへのパスが指定されていないと怒っているようです。

同じ問題に困っている人は見つかりますが、簡単には解決しなそうなので一旦あきらめます。こちらを参考にやってみたら成功しました。

https://gis.stackexchange.com/questions/82200/how-to-install-fiona-to-read-shapefile-attributes-with-osgeo4w/82206まずは環境変数に変数

GDAL_VERSIONSで値2.3.2を追加します。

以下のURLからFiona‑1.8.6‑cp37‑cp37m‑win_amd64.whlをダウンロードする。

https://www.lfd.uci.edu/~gohlke/pythonlibs/#fionaダウンロードファイルを適当な場所に移動したら

OSGeo4W Shellでインストールを実行C:\Windows\System32>python -m pip install c:/work/Fiona-1.8.6-cp37-cp37m-win_amd64.whl Processing c:/work/fiona-1.8.6-cp37-cp37m-win_amd64.whl Collecting click>=4.0 (from Fiona==1.8.6) Downloading https://files.pythonhosted.org/packages/fa/37/45185cb5abbc30d7257104c434fe0b07e5a195a6847506c074527aa599ec/Click-7.0-py2.py3-none-any.whl (81kB) |████████████████████████████████| 81kB 2.6MB/s Collecting munch (from Fiona==1.8.6) Downloading https://files.pythonhosted.org/packages/68/f4/260ec98ea840757a0da09e0ed8135333d59b8dfebe9752a365b04857660a/munch-2.3.2.tar.gz Collecting click-plugins>=1.0 (from Fiona==1.8.6) Downloading https://files.pythonhosted.org/packages/e9/da/824b92d9942f4e472702488857914bdd50f73021efea15b4cad9aca8ecef/click_plugins-1.1.1-py2.py3-none-any.wh l Collecting cligj>=0.5 (from Fiona==1.8.6) Downloading https://files.pythonhosted.org/packages/e4/be/30a58b4b0733850280d01f8bd132591b4668ed5c7046761098d665ac2174/cligj-0.5.0-py3-none-any.whl Collecting attrs>=17 (from Fiona==1.8.6) Downloading https://files.pythonhosted.org/packages/23/96/d828354fa2dbdf216eaa7b7de0db692f12c234f7ef888cc14980ef40d1d2/attrs-19.1.0-py2.py3-none-any.whl Requirement already satisfied: six>=1.7 in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from Fiona==1.8.6) (1.12.0) Installing collected packages: click, munch, click-plugins, cligj, attrs, Fiona Running setup.py install for munch ... done Successfully installed Fiona-1.8.6 attrs-19.1.0 click-7.0 click-plugins-1.1.1 cligj-0.5.0 munch-2.3.2先ほど失敗したfionaがインストールできましたのでもう一度GeoPandasを追加してみましょう。

C:\Windows\System32>python -m pip install geopandas Collecting geopandas Using cached https://files.pythonhosted.org/packages/74/42/f4b147fc7920998a42046d0c2e65e61000bc5d104f1f8aec719612cb2fc8/geopandas-0.5.0-py2.py3-none-any.whl Collecting pyproj (from geopandas) Using cached https://files.pythonhosted.org/packages/ce/36/2d8f1fe6bf32eebc0e880d9f27b394b97dd5119303986de691d7e91e1a51/pyproj-2.2.1-cp37-cp37m-win_amd64.whl Requirement already satisfied: fiona in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from geopandas) (1.8.6) Collecting shapely (from geopandas) Using cached https://files.pythonhosted.org/packages/a2/fb/7a7af9ef7a35d16fa23b127abee272cfc483ca89029b73e92e93cdf36e6b/Shapely-1.6.4.post2.tar.gz Requirement already satisfied: pandas in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from geopandas) (0.24.2) Requirement already satisfied: click>=4.0 in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from fiona->geopandas) (7.0) Requirement already satisfied: attrs>=17 in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from fiona->geopandas) (19.1.0) Requirement already satisfied: cligj>=0.5 in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from fiona->geopandas) (0.5.0) Requirement already satisfied: six>=1.7 in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from fiona->geopandas) (1.12.0) Requirement already satisfied: munch in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from fiona->geopandas) (2.3.2) Requirement already satisfied: click-plugins>=1.0 in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from fiona->geopandas) (1.1.1) Requirement already satisfied: numpy>=1.12.0 in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from pandas->geopandas) (1.15.4) Requirement already satisfied: pytz>=2011k in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from pandas->geopandas) (2018.7) Requirement already satisfied: python-dateutil>=2.5.0 in c:\progra~1\qgis3~1.4\apps\python37\lib\site-packages (from pandas->geopandas) (2.7.5) Installing collected packages: pyproj, shapely, geopandas Running setup.py install for shapely ... done Successfully installed geopandas-0.5.0 pyproj-2.2.1 shapely-1.6.4.post2今度は成功したようです。

動作確認

QGISを再起動してからPythonコンソールを開きます。

import geopandasを実行してみます。