- 投稿日:2020-01-12T23:55:20+09:00

AtCoder Beginner Contest 151 参戦記

AtCoder Beginner Contest 151 参戦記

ABC151A - Next Alphabet

1分半で突破. 書くだけ.

C = input() print(chr(ord(C[0]) + 1))ABC151B - Achieve the Goal

4分で突破. 書くだけ.

N, K, M = map(int, input().split()) A = list(map(int, input().split())) t = sum(A) if N * M > t + K: print(-1) else: print(max(N * M - t, 0))ABC151C - Count Order

7分半で突破. AC 後の WA は無視しないといけないところだけを気にすればよい.

N, M = map(int, input().split()) ac = [False] * N wa = [0] * N for _ in range(M): p, S = input().split() p = int(p) - 1 if S == 'AC': ac[p] = True else: if not ac[p]: wa[p] += 1 a = 0 b = 0 for i in range(N): if ac[i]: a += 1 b += wa[i] print(*[a, b])ABC151D - Maze Master

17分で突破. 見た瞬間に AtCoder Typical Contest 002A - 幅優先探索 を思い出したので、全箇所から幅優先探索して、最長をかき集める方向性で解いた.

H, W = map(int, input().split()) S = [input() for _ in range(H)] def f(i, j): t = [[-1] * W for _ in range(H)] t[i][j] = 0 q = [(i, j)] while q: y, x = q.pop(0) if y - 1 >= 0 and S[y - 1][x] != '#' and t[y - 1][x] == -1: t[y - 1][x] = t[y][x] + 1 q.append((y - 1, x)) if y + 1 < H and S[y + 1][x] != '#' and t[y + 1][x] == -1: t[y + 1][x] = t[y][x] + 1 q.append((y + 1, x)) if x - 1 >= 0 and S[y][x - 1] != '#' and t[y][x - 1] == -1: t[y][x - 1] = t[y][x] + 1 q.append((y, x - 1)) if x + 1 < W and S[y][x + 1] != '#' and t[y][x + 1] == -1: t[y][x + 1] = t[y][x] + 1 q.append((y, x + 1)) return max(max(tt) for tt in t) result = 0 for i in range(H): for j in range(W): if S[i][j] != '#': result = max(result, f(i, j)) print(result)ABC151E - Max-Min Sums

糸口すらつかめず敗退. 70分の間、順位が800番台から1300番台までずり落ちるのを眺める羽目になった.

- 投稿日:2020-01-12T23:54:52+09:00

AtCoder 第6回 ドワンゴからの挑戦状 予選 参戦記

- 投稿日:2020-01-12T23:54:01+09:00

AtCoder Beginner Contest 150 参戦記

AtCoder Beginner Contest 150 参戦記

ABC150A - 500 Yen Coins

5分で突破. 書くだけ. 問題文が中々表示されなかったせいで時間がかかった.

K, X = map(int, input().split()) if 500 * K >= X: print('Yes') else: print('No')ABC150B - Count ABC

2分半で突破. 書くだけ.

N = int(input()) S = input() result = 0 for i in range(N): if S[i:i+3] == 'ABC': result += 1 print(result)ABC150C - Count Order

26分で突破. C問題にしては難しいというか、最初は解ける気がしなかった. 素直に積算すればよかったんだなと…….

N = int(input()) P = list(map(int, input().split())) Q = list(map(int, input().split())) fac = [0] * 8 fac[1] = 1 for i in range(2, N): fac[i] = i * fac[i - 1] a = 0 l = list(range(1, N + 1)) for i in range(N): a += l.index(P[i]) * fac[len(l) - 1] l.remove(P[i]) b = 0 l = list(range(1, N + 1)) for i in range(N): b += l.index(Q[i]) * fac[len(l) - 1] l.remove(Q[i]) print(abs(a - b))ABC150D - Semi Common Multiple

敗退.

- 投稿日:2020-01-12T23:42:38+09:00

C# GUIアプリケーションからPythonスクリプトを実行する

はじめに

Pythonには機械学習をはじめとする優れたライブラリがたくさんある。一方C#はGUIアプリケーションの開発に広く利用されている言語である。したがってPythonスクリプトをC#アプリケーションから呼び出すことができれば、C#アプリケーション開発者にとって便利であるし、何よりGUIアプリケーションの幅も広がるはずだ。そこで今回、C#のGUIアプリケーションからPythonスクリプトを呼び出す方法について調べ、プロトタイプを作成してみた。

環境

- Windows10

- C#

- Python

開発したいプロトタイプ

開発したいプロトタイプの要件を以下に洗い出してみた。

- Pythonのパス、実行ディレクトリ(Working Directory)、Pythonスクリプトを指定し、実行することができる。

- 実行に長時間かかる場合を考慮し、途中で処理をキャンセルすることができる。

- 実行に長時間かかる場合に進捗状況が分かるよう、全ての標準出力、標準エラー出力をGUIのTextBoxに表示する。

- 以前に書いた 標準入出力を介してMOLファイルをSMILESに変換する のように、標準入力を受け取るPythonスクリプトの場合、ファイルを介さずにGUI側のデータをPythonスクリプトに渡すことにより、実行結果を手軽に受け取ることができる。このため標準入力も指定できるようにしたい。

- Pythonスクリプトの終了コードにより、正常終了かエラー終了かを判定し、MessageBoxにより表示する。

できたもの

画面

画面の説明

- Python Pathには、python.exeの場所をフルパスで指定する。Anacondaの場合は、Anacondaの仮想環境のpython.exeの場所を調べて指定する。

- Working Directoryには、Pythonスクリプトの実行ディレクトリを指定する。引数にファイルパスを指定する場合は、ここを起点とする相対パスで記載することもできる。

- Python Commandには、Pythonスクリプトの場所をフルパスで指定する。また引数があればそれも指定する。

- Standard Input には、Pythonスクリプトの標準入力に渡したいデータを入力する。標準入力を使わないPythonスクリプトの場合、無視される。

- Standard Output and Standard Errorには、Pythonスクリプトの全ての標準出力、標準エラー出力が表示される。

- 「Execute」ボタンにより処理を開始し、「Cancel」ボタンにより処理をキャンセルすることができる。

ソース

ソースは以下の通りだ。とても長くなったが、編集が面倒なためそのまま張り付ける(手抜き)。デザイン側のコードは両略した。GUI部品のオブジェクトの変数名は、コードから読み取ってほしい。ソースの解説は次項で説明する。

using System; using System.Diagnostics; using System.IO; using System.Text; using System.Threading; using System.Windows.Forms; namespace PythonCommandExecutor { public partial class Form1 : Form { private Process currentProcess; private StringBuilder outStringBuilder = new StringBuilder(); private int readCount = 0; private Boolean isCanceled = false; public Form1() { InitializeComponent(); } /// <summary> /// Textboxに文字列追加 /// </summary> public void AppendText(String data, Boolean console) { textBox1.AppendText(data); if (console) { textBox1.AppendText("\r\n"); Console.WriteLine(data); } } /// <summary> /// 実行ボタンクリック時の動作 /// </summary> private void button1_Click(object sender, EventArgs e) { // 前処理 button1.Enabled = false; button2.Enabled = true; isCanceled = false; readCount = 0; outStringBuilder.Clear(); this.Invoke((MethodInvoker)(() => this.textBox1.Clear())); // 実行 RunCommandLineAsync(); } /// <summary> /// コマンド実行処理本体 /// </summary> public void RunCommandLineAsync() { ProcessStartInfo psInfo = new ProcessStartInfo(); psInfo.FileName = this.textBox2.Text.Trim(); psInfo.WorkingDirectory = this.textBox3.Text.Trim(); psInfo.Arguments = this.textBox4.Text.Trim(); psInfo.CreateNoWindow = true; psInfo.UseShellExecute = false; psInfo.RedirectStandardInput = true; psInfo.RedirectStandardOutput = true; psInfo.RedirectStandardError = true; Process p = Process.Start(psInfo); p.EnableRaisingEvents = true; p.Exited += onExited; p.OutputDataReceived += p_OutputDataReceived; p.ErrorDataReceived += p_ErrorDataReceived; p.Start(); // 標準入力への書き込み using (StreamWriter sw = p.StandardInput) { sw.Write(this.textBox5.Text.Trim()); } //非同期で出力とエラーの読み取りを開始 p.BeginOutputReadLine(); p.BeginErrorReadLine(); currentProcess = p; } void onExited(object sender, EventArgs e) { int exitCode; if (currentProcess != null) { currentProcess.WaitForExit(); // 吐き出されずに残っているデータの吐き出し this.Invoke((MethodInvoker)(() => AppendText(outStringBuilder.ToString(), false))); outStringBuilder.Clear(); exitCode = currentProcess.ExitCode; currentProcess.CancelOutputRead(); currentProcess.CancelErrorRead(); currentProcess.Close(); currentProcess.Dispose(); currentProcess = null; this.Invoke((MethodInvoker)(() => this.button1.Enabled = true)); this.Invoke((MethodInvoker)(() => this.button2.Enabled=false)); if (isCanceled) { // 完了メッセージ this.Invoke((MethodInvoker)(() => MessageBox.Show("処理をキャンセルしました"))); } else { if (exitCode == 0) { // 完了メッセージ this.Invoke((MethodInvoker)(() => MessageBox.Show("処理が完了しました"))); } else { // 完了メッセージ this.Invoke((MethodInvoker)(() => MessageBox.Show("エラーが発生しました"))); } } } } /// <summary> /// 標準出力データを受け取った時の処理 /// </summary> void p_OutputDataReceived(object sender, System.Diagnostics.DataReceivedEventArgs e) { processMessage(sender, e); } /// <summary> /// 標準エラーを受け取った時の処理 /// </summary> void p_ErrorDataReceived(object sender, System.Diagnostics.DataReceivedEventArgs e) { processMessage(sender, e); } /// <summary> /// CommandLineプログラムのデータを受け取りTextBoxに吐き出す /// </summary> void processMessage(object sender, System.Diagnostics.DataReceivedEventArgs e) { if (e != null && e.Data != null && e.Data.Length > 0) { outStringBuilder.Append(e.Data + "\r\n"); } readCount++; // まとまったタイミングで吐き出し if (readCount % 5 == 0) { this.Invoke((MethodInvoker)(() => AppendText(outStringBuilder.ToString(), false))); outStringBuilder.Clear(); // スレッドを占有しないようスリープを入れる if (readCount % 1000 == 0) { Thread.Sleep(100); } } } /// <summary> /// キャンセルボタンクリック時の動作 /// </summary> private void button2_Click(object sender, EventArgs e) { if (currentProcess != null) { try { currentProcess.Kill(); isCanceled = true; } catch (Exception e2) { Console.WriteLine(e2); } } } private void button3_Click(object sender, EventArgs e) { // 標準入力エリアのクリア this.textBox5.Clear(); // 標準出力エリアのクリア this.textBox1.Clear(); } } }ソース解説

基本的には参考文献の寄せ集めになるのだが、説明を以下に記載する。

- RunCommandLineAsyncメソッド内でProcessクラスによりPythonスクリプトを実行している。

p.Start()以降は処理が非同期になるため、これ以降UIを操作する場合は、UIスレッドから実行しないと怒られてしまう。this.Invoke((MethodInvoker)(() => AppendText(outStringBuilder.ToString(), false)));のような呼び出しがところどころあるのはこのためである。p.EnableRaisingEvents = true;,p.Exited += onExited;により、プロセス終了時にonExitイベントハンドラが実行されるため、ここに後始末的な処理や、終了コードの判定、完了ダイアログの表示等を記載している。- キャンセルについては、キャンセル時に実行されるイベントハンドラの中でProcessクラスのKillメソッドを呼び出している。するとonExitイベントハンドラが実行され、通常終了時と同じになるため、それ以外に特別なことはしていない。

- 標準入力にデータを食わせるところは、

using (StreamWriter sw = p.StandardInput)から始まるところでやっている。- 標準出力、標準エラー出力の取り出しについては、

p.OutputDataReceived += p_OutputDataReceived;,ErrorDataReceived += p_ErrorDataReceived;によりそれぞれのイベントハンドラで受け取った標準出力、標準エラー出力を処理するようにしている。p.BeginOutputReadLine();,p.BeginErrorReadLine();により1行出力がある度にそれぞれのイベントハンドラが実行されるため、その中でTextBoxへの出力を行っている。1行毎にTextBoxに書き出すと大量の出力があるアプリの場合にGUIの処理に時間がかかる可能性もあるため、ある程度まとめて出力する等の工夫を行っている。実行例① 出力の多いPythonスクリプト(途中でエラー)を実行する

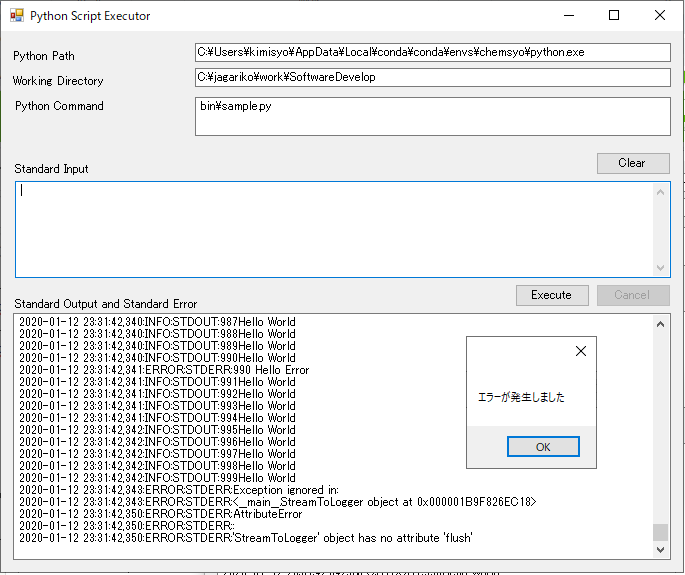

以下はサンプルとして作成した、ある程度標準出力や標準エラー出力の多いPythonスクリプトを実行した例である。標準エラーに出力されたエラーメッセージもTextBoxに出力され、かつ終了コードによりエラーのMessageBoxが表示されていることが分かる。

実行例② 標準入力を介してPythonスクリプトを実行する

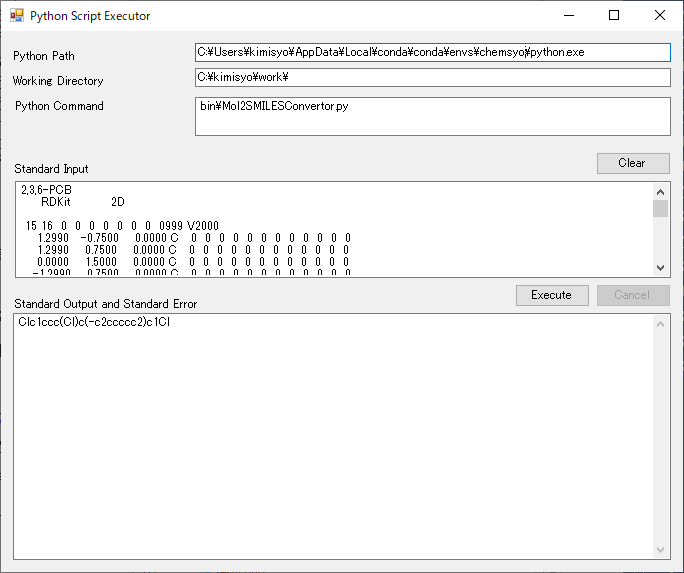

以下は、「標準入出力を介してMOLファイルをSMILESに変換する 」のスクリプトを本GUIを通して実行した図である。簡単なPythonスクリプトを書くだけでC#とPythonの処理結果の受け渡しができることを実感してもらえると思う。

おわりに

- async/awaitを使った方法で当初進めていたが、UIのデッドロックらしき現象が発生し、丸一日かけても解決できなかったため断念した。

- Pythonスクリプトの標準出力に進捗情報を出力することによって、C#側でプログレスバーによる進捗表示も簡単に行えると思う。

- 動作もまずまず安定しているため、このプロトタイプをベースに今後、C#からPythonの便利な機能をガンガン使い、魅力的なアプリを作ってみたい。

参考文献

- 投稿日:2020-01-12T23:40:03+09:00

AtCoderに参加してみたお話

はじめてAtCoderに参加してみた

Qiitaに記事を書くようになったり、仕事のことでいろいろ調べているうちに

「競技プログラミング」が流行っていることを知りました。

Twitterなんかでもはてブの記事がTLに流れてきたりするので興味本位でアカウントを作成。

いろいろ調べていると、コンテストが金曜日の夜や休日の夜に開催されるらしく、

そこに参加して問題を解いていくそう。年末年始で忙しく、アカウント作成だけで終わっていたのでやっとコンテストに参加することができました。

初めて参加したのがAtCoder Beginner Contest 151。

最近はkintoneをいじることが多く、jsでやってみようと思ったものの

おすすめはされていないみたいなので、数ヶ月前に少しだけ勉強したPythonで参加しました。初回なので何がなんだかパルプンテ

どきどきしながらPCの前で待機し、時間ピッタリにスタート。

画面の右下にカウントダウンが表示されます。

問題はAからFの6題があって、問題ごとに配点が違いました(Aは100点で100点ずつ増える)。問題がズラッと並べられているし、よくわからないけどAが初心者向けだろうということでAの問題を選択。

実行制限時間とか書いてるけどとりあえず無視…。解いた問題 ABC 151 A-Next Alphabet

【問題文】

$z$ でない英小文字 $C$ が与えられます。

アルファベット順で $C$ の次の文字を出力してください。

【制約】

$C$ は $z$ でない英小文字

【入力】

入力は以下の形式で標準入力から与えられる。

$C$

【出力】

アルファベット順で $C$ の次の文字を出力せよ。

【入力例】

a

【出力例】

b参加してみて

・まず標準入力という言葉に詰まる。

・Pythonの知識が抜け落ちている。

・JavaScriptからPythonの配列の考え方にシフトするのが大変だった。とりあえず解けたものの、ダサいコードになったので戒めとして貼っておくことにします。

ライブラリやメソッドを調べればよかったのかなと反省。alpha.pya = input() alpha = ["a", "b", "c", "d", "e", "f", "g", "h", "i", "j", "k", "l", "m", "n", "o", "p", "q", "r", "s", "t", "u", "v", "w", "x", "y", "z"] for i in range(len(alpha)): alphabet = alpha[i] if a == alphabet: s = i + 1 alphabet = alpha[s] print(alphabet) break実行制限時間が2secと書いているのに対してこのコードは17secかかっていました。

完全にアウト。これはハマるなあ、と終わった瞬間に思いました。終わりに

AtCoderは過去問なども公開されているので休日など時間のある際に

書く練習をしてみようと思います。

まずは毎週何かしらのコンテストに参加して慣れることも大切なんじゃないかなと感じました。

次回は実行時間も気にしながら解けるようにコードを書いてみようと思います!

- 投稿日:2020-01-12T23:16:16+09:00

Andible のパスワード/パスフレーズ自動入力

Ansible で使用するパスワードの指定(利用方法)に関するまとめ。

サマリ

ssh 接続のパスワード

- ssh のパスワードを自動入力するためには、sshpass が必要。

- sshpass は ansible のモジュールではないため、別途インストールが必要。

- sshpass は、"assword" という文字列 (プロンプト) が表示されるのを待って、パスワードを入力。

- ansible から呼び出す sshpass へ引数を渡す方法が用意されていないため、秘密鍵のパスフレーズ入力には(そのままでは)使用不可。

- 秘密鍵のパスフレーズは外さずに ssh-agent/ssh-add を使用。

- やむを得ずパスワード/パスフレーズを設定ファイル等に記載する場合には、ansible-vault で暗号化。

- ログインパスワードは一般的に sudo 権限昇格のパスワードと同じため、公開鍵暗号等に速やかに移行。

become (sudo) パスワード

- パスワードを記載する必要がある場合には、ansible-vault で暗号化。

公開鍵暗号の秘密鍵のファイル名の tips

- sshpass プログラムはデフォルトで "

assword" を含むプロンプトを期待している。- ssh のパスフレーズ入力プロンプトは "

Enter passphrase for key '...id_rsa':" となっており、"assword" を含まない。(そのため、sshpass がプロントを待ち続けて、そのままでは自動化できない)- 秘密鍵のファイル名に "

assword" を含めると、プロンプトに "assword" を含むことになり、sshpass がデフォルトのまま利用可能。ということで、秘密鍵のファイル名に "

assword" を含めれば、ansible でもパスフレーズを自動入力できるようになります。ansible-valut: vault-id の tips

- 暗号化された文字列のヘッダに label がついていても、vault-id-list に設定された ID のパスワードファイルを頭から順に試している模様。

- つまり、現バージョンでは、label は人間が識別するためのもので、ansible-vault プログラムにとっては、ほとんど意味をなしていない。(と思われる)

前提環境

OS 環境

コントロールホスト OS: Ubuntu 18.04

対象ホスト OS: Ubuntu 18.04 (docker) × 2/etc/os-releaseNAME="Ubuntu" VERSION="18.04.3 LTS (Bionic Beaver)" ID=ubuntu ID_LIKE=debian PRETTY_NAME="Ubuntu 18.04.3 LTS" VERSION_ID="18.04" HOME_URL="https://www.ubuntu.com/" SUPPORT_URL="https://help.ubuntu.com/" BUG_REPORT_URL="https://bugs.launchpad.net/ubuntu/" PRIVACY_POLICY_URL="https://www.ubuntu.com/legal/terms-and-policies/privacy-policy" VERSION_CODENAME=bionic UBUNTU_CODENAME=bionicPython 環境

Python仮想環境(ansible) $ pip freeze ansible==2.9.2 cffi==1.13.2 cryptography==2.8 Jinja2==2.10.3 MarkupSafe==1.1.1 passlib==1.7.2 pkg-resources==0.0.0 pycparser==2.19 PyYAML==5.2 six==1.13.0 (ansible) $接続先とパスフレーズ等接続環境

接続先 IP address ssh 接続 秘密鍵パスフレーズ ユーザ名&sudo 利用 172.17.0.2 公開鍵方式 " privkey_passphrase"pubkeyuser パスワード: " pubkeyuser_password"172.17.0.3 パスワード入力 - pwduser パスワード: " pwduser_password"Ansible 環境

Ansible バージョン

コントロールホストのansibleバージョン(ansible) $ ansible --version ansible 2.9.2 config file = /home/luser/work/ansible.cfg configured module search path = ['/home/luser/.ansible/plugins/modules', '/usr/share/ansible/plugins/modules'] ansible python module location = /home/luser/work/Python.d/envs/ansible/lib/python3.6/site-packages/ansible executable location = /home/luser/work/Python.d/envs/ansible/bin/ansible python version = 3.6.9 (default, Nov 7 2019, 10:44:02) [GCC 8.3.0] (ansible) $Ansible hosts ファイル

./hosts[hostgroup] 172.17.0.2 172.17.0.3Ansible の DEPRECATION WARNING の抑制

接続先で python2 ではなく、明示的に python3 を使うようにし、

DEPRECATION WARNINGを抑制するため、以下のような ansible.cfg をカレントディレクトリに置きます。

(deprecation_warnings=Falseを設定してもよいのですが、他の警告まで消えてしまわないように)ansible.cfg ファイル

./ansible.cfg(初期設定)[defaults] interpreter_python = /usr/bin/python3秘密鍵

動作確認用の秘密鍵をカレントディレクトリに置きます。

pubkeyuser_id_rsa ファイル

秘密鍵のパーミッション(ansible) $ ls -l pubkeyuser_id_rsa -rw------- 1 luser luser 1766 Jan 11 02:19 pubkeyuser_id_rsaファイル構成

初期ファイル構成(ansible) $ tree -a ./ ./ |-- ansible.cfg |-- host_vars | |-- 172.17.0.2.yml | `-- 172.17.0.3.yml |-- hosts |-- pubkeyuser_id_rsa `-- pubkeyuser_id_rsa_assword -> pubkeyuser_id_rsa 1 directory, 6 files (ansible) $前提ここまで。

Ansible で使用するパスワード(パスフレーズ)の種類

- ssh 接続時のパスワード/パスフレーズ

- sudo (become) 時のパスワード

ssh 接続のパスワード/パスフレーズ設定

参照: ssh – connect via ssh client binary — Ansible Documentation

ssh 接続は主に以下の2つの方法で行われます。

- 公開鍵暗号を用いた接続

- PAM パスワードによる接続

公開鍵暗号を用いた接続

公開鍵によるssh接続確認(ansible) $ ssh -i ./pubkeyuser_id_rsa pubkeyuser@172.17.0.2 Enter passphrase for key './pubkeyuser_id_rsa': ← ここで秘密鍵のパスフレーズを入力 Last login: Tue Jan 7 08:00:57 2020 from 172.17.0.1 $ id -a uid=1001(pubkeyuser) gid=1001(pubkeyuser) groups=1001(pubkeyuser),27(sudo) $ exit Connection to 172.17.0.2 closed. (ansible) $ansible での接続は以下のようになります。

公開鍵によるansible動作確認(ansible) $ ansible -i hosts -u pubkeyuser --private-key pubkeyuser_id_rsa 172.17.0.2 -m ping Enter passphrase for key 'pubkeyuser_id_rsa': ← ここで秘密鍵のパスフレーズを入力 172.17.0.2 | SUCCESS => { "changed": false, "ping": "pong" } (ansible) $ssh-agent/ssh-add の利用

sh-agent/ssh-add を利用して、パスフレーズの入力を避けることができます。

- Ansible does not expose a channel to allow communication between the user and the ssh process to accept a password manually to decrypt an ssh key when using this connection plugin (which is the default). The use of ssh-agent is highly recommended.

Ansible のドキュメントでも、ssh-agent の利用を強く推奨しています。

ssh-agentとssh-addを用いた接続確認(ansible) $ eval `ssh-agent` Agent pid 3256 (ansible) $ echo $SSH_AUTH_SOCK /tmp/ssh-dcXxsNEXR7zu/agent.3254 (ansible) $ ssh-add pubkeyuser_id_rsa Enter passphrase for pubkeyuser_id_rsa: Identity added: pubkeyuser_id_rsa (pubkeyuser_id_rsa) (ansible) $ ssh-add -l 2048 SHA256:Skhwkjn4nNRdRzWxNZBRGSPamcZikVkeBVpPhtFzgXw pubkeyuser_id_rsa (RSA) (ansible) $ ansible -i hosts -u pubkeyuser --private-key pubkeyuser_id_rsa 172.17.0.2 -m ping 172.17.0.2 | SUCCESS => { "changed": false, "ping": "pong" } (ansible) $csh 系を使用している場合には、

eval `ssh-agent -c`というように、-cオプションを付けます。バッチ処理におけるパスフレーズの設定

インタラクティブ(会話型)ではなく、バッチ処理のように、無人で起動するような場合には、設定が必要になります。

ssh-agent/ssh-add の利用

- ssh-agent は、(通常)ログアウトしてもプロセスが残り、ソケットが利用可能です。

- これを利用すると、非インタラクティブな処理でもパスワードの入力を省略できます。

以下のようなシェルスクリプトを ~/.bashrc から呼び出す (あるいは、.bashrc に直接記述する) と、既存のプロセスを再利用できます。

setup-ssh-agent.sh#!/bin/sh LANG=C SSH_AGENT=ssh-agent SSH_AGENT_SAVED=${SSH_AGENT_SAVED:-"${HOME}/.ssh/.${SSH_AGENT}"} AGENT_ENV="" if [ -f ${SSH_AGENT_SAVED} ] then eval $(tail -1 ${SSH_AGENT_SAVED}) > /dev/null if (ps -fp ${SSH_AGENT_PID} | sed -e 's/ */ /g' | cut -d' ' -f 8 | grep '^ssh-agent$' > /dev/null) then AGENT_ENV=$(tail -1 ${SSH_AGENT_SAVED}) else AGENT_ENV=$(${SSH_AGENT}) fi else AGENT_ENV=$(${SSH_AGENT}) fi echo ${AGENT_ENV} | tee ${SSH_AGENT_SAVED} chmod 0600 ${SSH_AGENT_SAVED}ssh-agent の環境変数設定を読み込んで、ansible コマンドを利用するようにするとよいでしょう。

非インタラクティブな実行でも、前処理として、実行済み ssh-agent/ssh-add に関する環境変数の読み込みなどを行う必要があります。

パスワード自体をファイルなどで保存しておく必要がない、という点で、推奨されます。sshpass の利用

sshpass を利用すると、パスフレーズ記載したファイルを指定して実行できます。

sshpass は ansible の一部ではないので、別途インストールする必要があります。

sshpassのインストールと動作確認(ansible) $ sudo apt install sshpass Reading package lists... Done Building dependency tree Reading state information... Done The following NEW packages will be installed: sshpass 0 upgraded, 1 newly installed, 0 to remove and 0 not upgraded. : Processing triggers for man-db (2.8.3-2ubuntu0.1) ... (ansible) $ ls -l ~/.ansible_rings/.pubkeyuser_passphrase -rw------- 1 luser luser 19 Jan 12 21:00 /home/luser/.ansible_rings/.pubkeyuser_passphrase (ansible) $ cat ~/.ansible_rings/.pubkeyuser_passphrase privkey_passphrase (ansible) $ sshpass -P "pubkeyuser_id_rsa':" -f ~/.ansible_rings/.pubkeyuser_passphrase ansible -i hosts -u pubkeyuser --private-key pubkeyuser_id_rsa 172.17.0.2 -m ping 172.17.0.2 | SUCCESS => { "changed": false, "ping": "pong" } (ansible) $ cat ~/.ansible_rings/.pubkeyuser_passphrase | sshpass -P "pubkeyuser_id_rsa':" -d 0 ansible -i hosts -u pubkeyuser --private-key pubkeyuser_id_rsa 172.17.0.2 -m ping 172.17.0.2 | SUCCESS => { "changed": false, "ping": "pong" } (ansible) $sshpass を非インタラクティブに使用する場合には、どこかに平文でパスフレーズを保存しておく必要があることに注意してください。

sshpass は、パスワード入力のプロンプトとして "assword" を期待しているので、秘密鍵のパスフレーズを入力する際のプロンプトを-Pオプションで指定する必要があります。ところが、ansible から sshpass へ引数を渡す方法が用意されていません。

そこで、"assword" がプロンプトに現れるように、プライベートキーのファイル名に "assword" を含めます。秘密鍵のファイル名設定(ansible) $ ln -s pubkeyuser_id_rsa pubkeyuser_id_rsa_assword (ansible) $ ls -l pubkeyuser_id_rsa pubkeyuser_id_rsa_assword -rw------- 1 luser luser 1766 Jan 11 02:19 pubkeyuser_id_rsa lrwxrwxrwx 1 luser luser 17 Jan 12 21:12 pubkeyuser_id_rsa_assword -> pubkeyuser_id_rsa (ansible) $ssh – connect via ssh client binary — Ansible Documentation の "password" の行を見ると、変数(var)として

var: ansible_password

var: ansible_ssh_pass

var: ansible_ssh_passwordが使えることが記載されています。

そこで、172.17.0.2 のホストにパスワードを設定します。

(tips として後述しますが、"ansible_ssh_password" は使用しないほうが無難です)./host_vars/172.17.0.2.yml--- # Remote User ansible_ssh_user: pubkeyuser # 秘密鍵 ansible_private_key_file: ./pubkeyuser_id_rsa_assword # SSH 共通引数 ansible_ssh_common_args: "-o PubkeyAuthentication=yes -o PasswordAuthentication=no -o StrictHostKeyChecking=no" # SSH 秘密鍵パスフレーズ ansible_ssh_pass: 'privkey_passphrase'動作確認(ansible) $ ansible 172.17.0.2 -m ping 172.17.0.2 | SUCCESS => { "changed": false, "ping": "pong" } (ansible) $パスフレーズの入力をせずに実行することができました。

PAM パスワードによる接続

ログインパスワードを用いた接続は避けたいところ1 ですが、何らかの事情でユーザのパスワードで ssh 接続を行わなければならないことがあります。

例えば、初期状態で、public キーがまだコピーできていないようなケースです。(可能であれば、ansible 実行前に公開鍵の登録を行いたいところです)sshの接続確認(ansible) $ ssh -o PubkeyAuthentication=no -o PasswordAuthentication=yes -o StrictHostKeyChecking=no pwduser@172.17.0.3 id -a pwduser@172.17.0.3's password: ← "pwduser" のログインパスワードを入力 uid=1001(pwduser) gid=1001(pwduser) groups=1001(pwduser),27(sudo) (ansible) $このようなケースでは、SSH のパスワードを入力する必要があります。

パスワードでのansibleの試み(ansible) $ ansible --ssh-common-args="-o PubkeyAuthentication=no -o PasswordAuthentication=yes -o StrictHostKeyChecking=no" -i hosts -u pwduser 172.17.0.3 -m ping 172.17.0.3 | UNREACHABLE! => { "changed": false, "msg": "Failed to connect to the host via ssh: Permission denied (publickey,password).", "unreachable": true } (ansible) $ansible では、

-kオプションを指定することで、SSH のパスワードを訊いてきますが、このオプションを付けないと、上のようにエラーになります。-kオプションを指定したansible実行(ansible) $ ansible --ssh-common-args="-o PubkeyAuthentication=no -o PasswordAuthentication=yes -o StrictHostKeyChecking=" -i hosts -u pwduser 172.17.0.3 -m ping -k SSH password: 172.17.0.3 | FAILED! => { "msg": "to use the 'ssh' connection type with passwords, you must install the sshpass program" } (ansible) $

-kオプションをつけることで、パスワード入力のプロンプトが出ましたが、こんどは、「sshpass プログラムをインストールしろ("to use the 'ssh' connection type with passwords, you must install the sshpass program")」と言ってきます。公開鍵での接続の際にも利用しましたが、sshpass は ansible の一部ではありませんので、別途インストールする必要があります。sshpassのインストール(ansible) $ sudo apt install sshpass Reading package lists... Done Building dependency tree Reading state information... Done The following NEW packages will be installed: sshpass 0 upgraded, 1 newly installed, 0 to remove and 0 not upgraded. : Processing triggers for man-db (2.8.3-2ubuntu0.1) ... (ansible) $sshpass をインストールすると、動作するようになります。

sshpassインストール後の接続確認(ansible) $ ansible --ssh-common-args="-o PubkeyAuthentication=no -o PasswordAuthentication=yes -o StrictHostKeyChecking=no" -i hosts -u pwduser 172.17.0.3 -m ping -k SSH password: 172.17.0.3 | SUCCESS => { "changed": false, "ping": "pong" } (ansible) $バッチ処理におけるパスフレーズの設定

公開鍵の場合と同様に、172.17.0.3.yml で変数を設定します。

./host_vars/172.17.0.3.yml--- # Remote User ansible_ssh_user: pwduser # パスワード認証の指定 ansible_ssh_common_args: '-o PreferredAuthentications=password -o PubkeyAuthentication=no -o PasswordAuthentication=yes -o StrictHostKeyChecking=no' # 認証パスワード ansible_ssh_pass: 'pwduser_password'(ansible) $ ansible 172.17.0.3 -m ping 172.17.0.3 | SUCCESS => { "changed": false, "ping": "pong" } (ansible) $パスワードの入力をせずに実行することができました。

sudo (become) 時のパスワード

参照: sudo – Substitute User DO — Ansible Documentation

sudo – Substitute User DO — Ansible Documentation を参照すると、パスワードの設定は以下のように記載されています。

ini entries:

[sudo_become_plugin]

password = VALUEenv:ANSIBLE_BECOME_PASS

env:ANSIBLE_SUDO_PASS

var: ansible_become_password

var: ansible_become_pass

var: ansible_sudo_pass変数(var)

ansible_become_passを使って、172.17.0.2.ymlと172.17.0.3.ymlに設定します。./host_vars/172.17.0.2.yml--- # Remote User ansible_ssh_user: pubkeyuser # 秘密鍵 ansible_private_key_file: ./pubkeyuser_id_rsa_assword # SSH 共通引数 ansible_ssh_common_args: "-o PubkeyAuthentication=yes -o PasswordAuthentication=no -o StrictHostKeyChecking=no" # SSH 秘密鍵パスフレーズ ansible_ssh_pass: 'privkey_passphrase' # become (sudo) パスワード ansible_sudo_pass: 'pubkeyuser_password'./host_vars/172.17.0.3.yml--- # Remote User ansible_ssh_user: pwduser # パスワード認証の指定 ansible_ssh_common_args: '-o PreferredAuthentications=password -o PubkeyAuthentication=no -o PasswordAuthentication=yes -o StrictHostKeyChecking=no' # 認証パスワード ansible_ssh_pass: 'pwduser_password' # become (sudo) パスワード ansible_sudo_pass: 'pwduser_password'パスワードを入力せずに(非インタラクティブで) become が実行できるようになります。

非インタラクティブなbecomeの動作確認(ansible) $ ( set -x; for h in 172.17.0.2 172.17.0.3 hostgroup; do ansible $h -m command -a 'id -a'; ansible $h -m command -a 'id -a' -b; done ) + for h in 172.17.0.2 172.17.0.3 hostgroup + ansible 172.17.0.2 -m command -a 'id -a' 172.17.0.2 | CHANGED | rc=0 >> uid=1001(pubkeyuser) gid=1001(pubkeyuser) groups=1001(pubkeyuser),27(sudo) + ansible 172.17.0.2 -m command -a 'id -a' -b 172.17.0.2 | CHANGED | rc=0 >> uid=0(root) gid=0(root) groups=0(root) + for h in 172.17.0.2 172.17.0.3 hostgroup + ansible 172.17.0.3 -m command -a 'id -a' 172.17.0.3 | CHANGED | rc=0 >> uid=1001(pwduser) gid=1001(pwduser) groups=1001(pwduser),27(sudo) + ansible 172.17.0.3 -m command -a 'id -a' -b 172.17.0.3 | CHANGED | rc=0 >> uid=0(root) gid=0(root) groups=0(root) + for h in 172.17.0.2 172.17.0.3 hostgroup + ansible hostgroup -m command -a 'id -a' 172.17.0.3 | CHANGED | rc=0 >> uid=1001(pwduser) gid=1001(pwduser) groups=1001(pwduser),27(sudo) 172.17.0.2 | CHANGED | rc=0 >> uid=1001(pubkeyuser) gid=1001(pubkeyuser) groups=1001(pubkeyuser),27(sudo) + ansible hostgroup -m command -a 'id -a' -b 172.17.0.3 | CHANGED | rc=0 >> uid=0(root) gid=0(root) groups=0(root) 172.17.0.2 | CHANGED | rc=0 >> uid=0(root) gid=0(root) groups=0(root) (ansible) $ansible-vault を利用した暗号化

参照: Ansible Vault — Ansible Documentation

パスワード/パスフレーズを各変数に設定することで、入力せずに実行できるようになりましたが、パスワード/パスフレーズが平文で残っているのは好ましくありません。

そこで、ansible-vault を利用して、暗号化します。

ansible-vault で、以下のようなことができます。

- ファイル全体を暗号化する

- key=value を暗号化する

- value 部分を暗号化する

詳しいことは参照先の "Ansible Vault — Ansible Documentation" を見ていただくとして、ここでは、3番目の value 部分を暗号化した実例を示します。

ansible-vault には、vault-id というものがありますが、これがドキュメントではわかりにくくなっています。

--vault-idオプションで、ID リスト (カンマ区切りで複数指定可) を提示し、--encrypt-vault-idオプションで、暗号化時の ID (label) を指定します。- vault-id の形式は、"label@パスワードファイル名" という形で、label とパスワードの記載されたファイル名の組み合わせになります。

ansible-vault の暗号化/復号パスワードを以下のようなファイルに設定することにします。

(ansible) $ tree -a ~/.ansible_rings/ /home/luser/.ansible_rings/ |-- .vault_pass_sample.txt |-- .vault_pass_sample1.txt |-- .vault_pass_sample2.txt |-- .vault_pass_sample3.txt |-- .vault_pass_sample4.txt `-- .vault_pass_sample_default.txt 0 directories, 6 files (ansible) $~/.ansible_rings/.vault_pass_sample.txtsamplepassword~/.ansible_rings/.vault_pass_sample1.txtsample1password~/.ansible_rings/.vault_pass_sample2.txtsample2password~/.ansible_rings/.vault_pass_sample3.txtsample3password~/.ansible_rings/.vault_pass_sample4.txtsample4password~/.ansible_rings/.vault_pass_sample_default.txtdefaultPassword次に、ansible.cfg に ansible-vault の設定を行います。

./ansible.cfg[defaults] interpreter_python = /usr/bin/python3 # インベントリ inventory = hosts # ansible-vault 関連 vault_identity = sample vault_encrypt_identity = sample vault_identity_list = sample@~/.ansible_rings/.vault_pass_sample.txt,sample1@~/.ansible_rings/.vault_pass_sample1.txt,sample2@~/.ansible_rings/.vault_pass_sample2.txt,sample3@~/.ansible_rings/.vault_pass_sample3.txt,sample4@~/.ansible_rings/.vault_pass_sample4.txt,@~/.ansible_rings/.vault_pass_sample_default.txt #[privilege_escalation] ## become (sudo) #become = Trueansible.cfg の設定が終わったら、パスワード/パスフレーズの暗号化を行います。

ansible-vaultによる暗号化(ansible) $ ( set -x; ( while read n p s; do ansible-vault encrypt_string -v --encrypt-vault-id $s -n $n $p; done ) << EOT ansible_ssh_pass privkey_passphrase sample1 ansible_sudo_pass pubkeyuser_password sample2 ansible_ssh_pass pwduser_password sample3 ansible_sudo_pass pwduser_password sample4 EOT ) + cat + read n p s + ansible-vault encrypt_string -v --encrypt-vault-id sample1 -n ansible_ssh_pass privkey_passphrase Using /home/luser/work/Ansible.d/passwordtest.withVault/ansible.cfg as config file ansible_ssh_pass: !vault | $ANSIBLE_VAULT;1.2;AES256;sample1 31386662393263333631396165646631616139323064346631633931363563323330643035393366 3132633136633734383665373135343833353835396461640a633132663862633130653735633436 61613535333964383162373135383966643438303661326333303337656263626262303232333961 3436656633316232310a636336323737323761346535613761623038623362636565633934656437 30633462363565383035626165393832626465636161313932333866306266666638 Encryption successful + read n p s + ansible-vault encrypt_string -v --encrypt-vault-id sample2 -n ansible_sudo_pass pubkeyuser_password Using /home/luser/work/Ansible.d/passwordtest.withVault/ansible.cfg as config file ansible_sudo_pass: !vault | $ANSIBLE_VAULT;1.2;AES256;sample2 34646236623634393565333836346238333662313466323762316462636637633735326330393261 6335373233666334386362626661653363373563393763360a633161336663303737376535393638 65333033333330326534643233336466363931336633643464373862653663316665373331616566 3333343232306266350a656464363232376661626135613063333032353037376333323830363538 35333362353534376664613736343765373862333631346338656634383262373935 Encryption successful + read n p s + ansible-vault encrypt_string -v --encrypt-vault-id sample3 -n ansible_ssh_pass pwduser_password Using /home/luser/work/Ansible.d/passwordtest.withVault/ansible.cfg as config file ansible_ssh_pass: !vault | $ANSIBLE_VAULT;1.2;AES256;sample3 39623031313762626535383264623838613435306233323863363466363231663265363230653666 3739666333396133313332613563626238323665636638300a653433303139373734326562633735 36303536366533323665623436633939393138393064633435383063366531373662343339643631 6263386465663838630a623365383336373536343039343663393662396162613433646132373438 61326165326566373761613831663961363237376563653863666330336330396139 Encryption successful + read n p s + ansible-vault encrypt_string -v --encrypt-vault-id sample4 -n ansible_sudo_pass pwduser_password Using /home/luser/work/Ansible.d/passwordtest.withVault/ansible.cfg as config file ansible_sudo_pass: !vault | $ANSIBLE_VAULT;1.2;AES256;sample4 62346235306363343334653464653235373632386165383735343038313765633133376462663737 3532323962316536663333363366666432383832323531340a336132376130326430633765333566 66336238653038366233323834383862303262336435623039316135613139303862306133646562 3162393332343931370a366365666564326462396365376434353234353661353763626465383734 65383938383535356137313531613631646366363231393737656266383134353239 Encryption successful + read n p s (ansible) $上では、標準出力に表示させていますが、ファイルに書き込む場合には --output オプションが使用できます。

それぞれの出力を、変数として設定します。

host_vars/172.17.0.2.yml--- # Remote User ansible_ssh_user: pubkeyuser # 秘密鍵 ansible_private_key_file: ./pubkeyuser_id_rsa_assword # SSH 共通引数 ansible_ssh_common_args: "-o PubkeyAuthentication=yes -o PasswordAuthentication=no -o StrictHostKeyChecking=no" # SSH 秘密鍵パスフレーズ #ansible_ssh_pass: 'privkey_passphrase' ansible_ssh_pass: !vault | $ANSIBLE_VAULT;1.2;AES256;sample1 31386662393263333631396165646631616139323064346631633931363563323330643035393366 3132633136633734383665373135343833353835396461640a633132663862633130653735633436 61613535333964383162373135383966643438303661326333303337656263626262303232333961 3436656633316232310a636336323737323761346535613761623038623362636565633934656437 30633462363565383035626165393832626465636161313932333866306266666638 # become (sudo) パスワード #ansible_sudo_pass: 'pubkeyuser_password' ansible_sudo_pass: !vault | $ANSIBLE_VAULT;1.2;AES256;sample2 34646236623634393565333836346238333662313466323762316462636637633735326330393261 6335373233666334386362626661653363373563393763360a633161336663303737376535393638 65333033333330326534643233336466363931336633643464373862653663316665373331616566 3333343232306266350a656464363232376661626135613063333032353037376333323830363538 35333362353534376664613736343765373862333631346338656634383262373935host_vars/172.17.0.3.yml--- # Remote User ansible_ssh_user: pwduser # パスワード認証の指定 ansible_ssh_common_args: '-o PreferredAuthentications=password -o PubkeyAuthentication=no -o PasswordAuthentication=yes -o StrictHostKeyChecking=no' # 認証パスワード #ansible_ssh_pass: 'pwduser_password' ansible_ssh_pass: !vault | $ANSIBLE_VAULT;1.2;AES256;sample3 39623031313762626535383264623838613435306233323863363466363231663265363230653666 3739666333396133313332613563626238323665636638300a653433303139373734326562633735 36303536366533323665623436633939393138393064633435383063366531373662343339643631 6263386465663838630a623365383336373536343039343663393662396162613433646132373438 61326165326566373761613831663961363237376563653863666330336330396139 # become (sudo) パスワード #ansible_sudo_pass: 'pwduser_password' ansible_sudo_pass: !vault | $ANSIBLE_VAULT;1.2;AES256;sample4 62346235306363343334653464653235373632386165383735343038313765633133376462663737 3532323962316536663333363366666432383832323531340a336132376130326430633765333566 66336238653038366233323834383862303262336435623039316135613139303862306133646562 3162393332343931370a366365666564326462396365376434353234353661353763626465383734 65383938383535356137313531613631646366363231393737656266383134353239(ansible) $ ( set -x; for h in 172.17.0.2 172.17.0.3 hostgroup; do ansible $h -m command -a 'id -a'; ansible $h -m command -a 'id -a' -b; done ) + for h in 172.17.0.2 172.17.0.3 hostgroup + ansible 172.17.0.2 -m command -a 'id -a' 172.17.0.2 | CHANGED | rc=0 >> uid=1001(pubkeyuser) gid=1001(pubkeyuser) groups=1001(pubkeyuser),27(sudo) + ansible 172.17.0.2 -m command -a 'id -a' -b 172.17.0.2 | CHANGED | rc=0 >> uid=0(root) gid=0(root) groups=0(root) + for h in 172.17.0.2 172.17.0.3 hostgroup + ansible 172.17.0.3 -m command -a 'id -a' 172.17.0.3 | CHANGED | rc=0 >> uid=1001(pwduser) gid=1001(pwduser) groups=1001(pwduser),27(sudo) + ansible 172.17.0.3 -m command -a 'id -a' -b 172.17.0.3 | CHANGED | rc=0 >> uid=0(root) gid=0(root) groups=0(root) + for h in 172.17.0.2 172.17.0.3 hostgroup + ansible hostgroup -m command -a 'id -a' 172.17.0.2 | CHANGED | rc=0 >> uid=1001(pubkeyuser) gid=1001(pubkeyuser) groups=1001(pubkeyuser),27(sudo) 172.17.0.3 | CHANGED | rc=0 >> uid=1001(pwduser) gid=1001(pwduser) groups=1001(pwduser),27(sudo) + ansible hostgroup -m command -a 'id -a' -b 172.17.0.2 | CHANGED | rc=0 >> uid=0(root) gid=0(root) groups=0(root) 172.17.0.3 | CHANGED | rc=0 >> uid=0(root) gid=0(root) groups=0(root) (ansible) $ssh のパスフレーズは、ssh-agent/ssh-add を使うことが推奨されていますし、become(sudo)のパスワードは、ansible-vault で暗号化し、復号パスワードが記載されたファイルは、厳重に管理しましょう。

ssh のパスワード設定の tips

- ssh – connect via ssh client binary — Ansible Documentation の password の説明では、変数名として

ansible_ssh_passwordが使えるように記載されているが、ansible_ssh_passとansible_passwordのみが実装されており、ansible_ssh_passwordは実装されていない。var: ansible_password

var: ansible_ssh_pass

var: ansible_ssh_password

- 以下の修正を加えれば使用できるようになるが、回避策(

ansible_ssh_passかansible_passwordを使用する)があるのと、まとめようという issue もあるで、修正されるかどうかは不明。ansible-constants.py.patch*** constants.py.orig 2019-12-04 23:10:58.000000000 +0000 --- constants.py 2020-01-10 05:16:07.520928899 +0000 *************** *** 140,146 **** # connection common remote_addr=('ansible_ssh_host', 'ansible_host'), remote_user=('ansible_ssh_user', 'ansible_user'), ! password=('ansible_ssh_pass', 'ansible_password'), port=('ansible_ssh_port', 'ansible_port'), pipelining=('ansible_ssh_pipelining', 'ansible_pipelining'), timeout=('ansible_ssh_timeout', 'ansible_timeout'), --- 140,146 ---- # connection common remote_addr=('ansible_ssh_host', 'ansible_host'), remote_user=('ansible_ssh_user', 'ansible_user'), ! password=('ansible_ssh_password', 'ansible_ssh_pass', 'ansible_password'), port=('ansible_ssh_port', 'ansible_port'), pipelining=('ansible_ssh_pipelining', 'ansible_pipelining'), timeout=('ansible_ssh_timeout', 'ansible_timeout'),

一般に、ログインパスワードを用いた接続で入力するパスワードと、sudo によって管理者権限へ昇格する場合のパスワードは同じため、ログインパスワードが漏れると、対象サーバ上の管理者権限が奪われるリスクが高くなります。ログインのためのパスワード/パスフレーズと、権限昇格のための sudo で用いるパスワードは、分けておく(つまり、ログインはできるだけログインパスワード以外で利用する)ことをお勧めします。 ↩

- 投稿日:2020-01-12T23:12:35+09:00

【初心者向け】再帰関数(ハノイの塔を分かりやすく!)

1.はじめに

再帰関数はプログラミングの最初の関門かもしれない。Pythonでハノイの塔を解きながら、再帰関数をマスターしよう。

再帰関数は、マトリョーシカのように、プログラムの構造が入れ子になっている。ぜひ、マトリョーシカをイメージしながら、以下の説明を読んでみてください。

2.ハノイの塔

ハノイの塔は、以下を参照してください。ハノイの塔

簡単に説明すると、棒が3本あって、板を刺せるようになっている。右に板が何枚かある。板の大きさは下が一番大きくて、上に行くほど小さくなる。板を一枚ずつ動かして、最終的に全ての板を真ん中の棒に移したい。但し、小さい板の上に大きな板は置けない。

プログラミングの学習では、再帰関数を使って解く問題だ。

3.考え方

1枚は超簡単。右から真ん中に移して、おしまい。

2枚の場合がポイント。いきなり、右の棒の小さい板を真ん中に移してはダメ。

(1)まず、小さい板は、一旦、左のワーク用の棒に移す。

(2)それから、右に残った、大きい板を真ん中に移す。

(3)その後、小さい板を左から真ん中に移せば、OKだ。つまり、n枚の板(この場合、2枚)、すべてを真ん中に移すためには、(1)一番下の一番大きい板を除くn-1枚(この場合、1枚)を、一旦、左のワーク用の棒に移す必要がある。

(2)そして、一番下の一番大きい板を右から真ん中に移した後で、(3)左のワーク用の棒にあるn-1枚の板(この場合、1枚)すべてを、真ん中に移せば、OKだ。以下の説明では、上記の(1)から(3)を繰り返し説明する。以下の説明で出てくる(1)から(3)も上記の(1)から(3)と、基本的には、同じ意味になる。但し、「どこから、どこへ」は、操作の意味により、「右、真ん中、左」の中で、場合によって変化する。

4.再帰関数での解法

以下がハノイの塔の解法プログラムになる。後ほど実行するが、使う際には、板の枚数をNに代入する。

start=list(range(N,0,-1));end=[];tmp=[];i=0 #1 def print_hanoi(): #2 print(start,end,tmp) def hanoi(n,start,end,tmp): #3 if n<=0: return #4 hanoi(n-1,start,tmp,end) #5 end.append(start.pop()) #6 print_hanoi() #7 global i; i+=1 #8 print('上記は',i,'回目の操作後の状態') #9 hanoi(n-1,tmp,end,start) #10 print_hanoi() #11 print('上記は最初の状態') #12 hanoi(N,start,end,tmp) #13簡単に解説する。数字はプログラムで#を付けた部分に該当する。

1.startは最初に右の棒に刺さっている板を表すリスト。初期状態は、下が一番大きく、1ずつ小さくなり、最後は1となるリスト。

endは最終的に板を映したい真ん中の棒に刺さっている板を表すリスト。最初は何も刺さっていないので、空(から)のリスト。

tmpはワーク用の棒に刺さっている板を表すリスト。こちらも最初は何も刺さっていないので空のリスト。

iは、何回目の操作かを表すために設定。

2.状態を表す。順番に「右、真ん中、左」の棒に刺さっている板を、リストで表す。

3.これがハノイの塔を解く関数。但し、再帰関数をとして使うので、マトリョーシカのように、入れ子になる。

引数に注意してもらいたい。最初のnが板の枚数。次がstartが右で、それを次のendに動かしたい。最後のtmpがワーク用。4.これがベースとなる終了条件。動かすべき板が0になれば、終了。

ベースとなる終了条件を忘れると、無限ループに陥るので、注意が必要だ。5.3の関数を再帰的に使っている。但し、3の関数は第一引数のn枚すべてを、第二引数のstartから第三引数のendに移すように定義した。(第四引数はワーク用のtmpとした。)

ここでは、(1)一番下のnを除いた 残りのn-1枚すべて(第一引数)をstart(第二引数)から一旦、tmp(第三引数)に移す。(第四引数は残りの引数であるend。)

こうすることで、上からn-1枚はtmpに移るので、一番下にあるnを動かすことができるようになる。

6.5で上からn-1枚をtmpに移したので、右のstartの棒には、一番下のnだけが残っている。(2)その一番下の板を取り出して

start.pop()、真ん中のendの棒に移すend.append()(リストへの追加)。7.ここで状態をプリント。

8.回数をカウントアップ。

9.分かりやすいように何回目の操作後かをプリント。

10.6で一番大きい板は真ん中に移っている。(3)その一番大きい板の上に、左のワーク用の棒にあるn-1枚の板すべてを移す。引数に注目すると、やっていることが分かると思う。

11.ここで最初の状態をプリント。

12.分かりやすいようにコメントをプリント。

13.実際の実行。Nは実際に使う際に、与える。

5.実際にやってみよう

1.まずは板が1枚の場合。やるまでも無い気がするが何事も念入りに。Nはプログラムの冒頭で指定している。

N=1;start=list(range(N,0,-1));end=[];tmp=[];i=0 #1 def print_hanoi(): #2 print(start,end,tmp) def hanoi(n,start,end,tmp): #3 if n<=0: return #4 hanoi(n-1,start,tmp,end) #5 end.append(start.pop()) #6 print_hanoi() #7 global i; i+=1 #8 print('上記は',i,'回目の操作後の状態') #9 hanoi(n-1,tmp,end,start) #10 print_hanoi() #11 print('上記は最初の状態') #12 hanoi(N,start,end,tmp) #13結果は以下の通り。右から真ん中に移して、おしまい。

ここでは、3の「考え方」で説明した(2)の部分だけが実行される。(1)に相当する#5や(2)に相当する#10を見てもらうと分かるけど、n-1が0になり、#4で何も実行されないことになる。

[1] [] [] 上記は最初の状態 [] [1] [] 上記は 1 回目の操作後の状態2.次は、2枚のケース。1枚のケースと異なり、2枚のケース以降は左のワーク用の棒を使う。

N=2;start=list(range(N,0,-1));end=[];tmp=[];i=0 #1 def print_hanoi(): #2 print(start,end,tmp) def hanoi(n,start,end,tmp): #3 if n<=0: return #4 hanoi(n-1,start,tmp,end) #5 end.append(start.pop()) #6 print_hanoi() #7 global i; i+=1 #8 print('上記は',i,'回目の操作後の状態') #9 hanoi(n-1,tmp,end,start) #10 print_hanoi() #11 print('上記は最初の状態') #12 hanoi(N,start,end,tmp) #13結果は以下の通り。数字は板の大きさを表す。リストの数字は、下にあるものから順番に出力するようにしている。つまり、リストの中の数字が降順に並んでいることがハノイの塔のルール上、必要となる。

2枚のケースでは、

(1)まず、小さい板を右から左のワーク用の棒に移す。(1回目の操作)

(2)そして、そうすることで、右の大きい板を真ん中に移すことが出来る。(2回目の操作)

(3)最後に、左の小さい板を真ん中の大きい板の上に移せば、OKだ。(3回目の操作)[2, 1] [] [] 上記は最初の状態 [2] [] [1] 上記は 1 回目の操作後の状態 [] [2] [1] 上記は 2 回目の操作後の状態 [] [2, 1] [] 上記は 3 回目の操作後の状態3.3枚以降はプログラムは省略。Nに代入する枚数を変えればOKだ。

結果は以下の通り。[3, 2, 1] [] [] 上記は最初の状態 [3, 2] [1] [] 上記は 1 回目の操作後の状態 [3] [1] [2] 上記は 2 回目の操作後の状態 [3] [] [2, 1] 上記は 3 回目の操作後の状態 [] [3] [2, 1] 上記は 4 回目の操作後の状態 [1] [3] [2] 上記は 5 回目の操作後の状態 [1] [3, 2] [] 上記は 6 回目の操作後の状態 [] [3, 2, 1] [] 上記は 7 回目の操作後の状態(1)1回目から3回目までの操作で、2枚(つまり、n-1枚)を左のワーク用の棒に移している。この1回目から3回目の中に、2枚の場合の(1)から(3)が含まれる。もちろん、「どこから、どこへ」の詳細は、ケースバイケース。

(2)そして、4回目の操作で、一番大きい3枚目(つまり、n枚目)を右から真ん中に移す。

(3)その後、5回目から7回目までの操作で、左のワークにある2枚(つまり、n-1枚)を真ん中の一番大きい板の上に移して、おしまい。この5回目から7回目の中にも、2枚の場合の(1)から(3)が含まれる。もちろん、「どこから、どこへ」の詳細は、ケースバイケース。

ここで気をつけてほしいのは、まず(1)で2枚を左のワーク用の棒に移す方法。2でやった2枚を右から真ん中に移すケースでは、左がワークになった。しかし、3枚の(1)で2枚を右から左に移すケースでは、当然のことながら、真ん中がワーク用になる。だから、1回目の操作で一番小さい板を、真ん中に移すことになる。

(3)で2枚を左から真ん中に移す場合も同様。ここでは右がワークになるので、5回目の操作では、一番小さい板を左から右に移している。

4.最後に4枚のケースをやって、おしまいにしよう。

[4, 3, 2, 1] [] [] 上記は最初の状態 [4, 3, 2] [] [1] 上記は 1 回目の操作後の状態 [4, 3] [2] [1] 上記は 2 回目の操作後の状態 [4, 3] [2, 1] [] 上記は 3 回目の操作後の状態 [4] [2, 1] [3] 上記は 4 回目の操作後の状態 [4, 1] [2] [3] 上記は 5 回目の操作後の状態 [4, 1] [] [3, 2] 上記は 6 回目の操作後の状態 [4] [] [3, 2, 1] 上記は 7 回目の操作後の状態 [] [4] [3, 2, 1] 上記は 8 回目の操作後の状態 [] [4, 1] [3, 2] 上記は 9 回目の操作後の状態 [2] [4, 1] [3] 上記は 10 回目の操作後の状態 [2, 1] [4] [3] 上記は 11 回目の操作後の状態 [2, 1] [4, 3] [] 上記は 12 回目の操作後の状態 [2] [4, 3] [1] 上記は 13 回目の操作後の状態 [] [4, 3, 2] [1] 上記は 14 回目の操作後の状態 [] [4, 3, 2, 1] [] 上記は 15 回目の操作後の状態(1)1回目から7回目までの操作で、3枚(つまり、n-1枚)を左のワーク用の棒に移している。この1回目から7回目の中に、3枚の場合の(1)から(3)が含まれる。そして、3枚の場合の(1)の中に、2枚の場合の(1)から(3)が含まれ、3枚の場合の(3)の中にも、2枚の場合の(1)から(3)が含まれる。

(2)そして、8回目の操作で、一番大きい4枚目(つまり、n枚目)を右から真ん中に移す。

(3)その後、9回目から15回目までの操作で、左のワークにある3枚(つまり、n-1枚)を真ん中の一番大きい板の上に移して、おしまい。この9回目から15回目の中に、3枚の場合の(1)から(3)が含まれる。そして、3枚の場合の(1)の中に、2枚の場合の(1)から(3)が含まれ、3枚の場合の(3)の中にも、2枚の場合の(1)から(3)が含まれる。

今回も3枚のときと同様、ワーク用は変化する。

6.まとめ

ハノイの塔におけるワーク用などの役割は、板の枚数などによって、変化する。

しかし、着目してほしいのは、5の2枚、3枚、4枚に記載した(1)(2)(3)の部分だ。

(1)まず、上からn-1枚を、右から左のワーク用に移し、

(2)そうすることで、一番下の大きい板を、右から真ん中に移すことが出来て、

(3)最終的に、上からn-1枚を、左のワークから真ん中に移せば、OKだ。4のプログラムで言えば、(1)が5に、(2)が6に、(3)が10に、対応する。この操作を、マトリョーシカよろしく、繰り返し、行っているのが、ハノイの塔の解法に使われている再帰関数ということになる。(なお、正確に言うと、純粋な再帰の部分は(1)と(3)です。)

7.参考サイト

以下のサイトは、c++で記載されていますが、とても参考になるサイトです。著者の方は、僕が個人的に尊敬している方です。

- 投稿日:2020-01-12T23:08:09+09:00

Jupyter学習ノート_006

データを地図に見る

google colabにデータを地図上で表示するライブラリfoliumを使ってみる。

- サンプル1(東京駅の地図を見る)

- parm1: location[緯度, 経度]

- parm2: zom_start=18 (0から18まで拡大/縮小可能です)

folium_01.pyimport folium map_ = folium.Map(location=[35.681384, 139.766073], zoom_start=18) map_folium_02.pyimport folium #京急線の泉岳寺〜横浜までの緯度と経度を定義する kk_ekis = [ ['泉岳寺',35.638692,139.74002], ['品川',35.630152,139.74044], ['北品川',35.622716,139.739152], ['新馬場',35.61762,139.741366], ['青物横丁',35.609351,139.742905], ['鮫洲',35.605144,139.742547], ['立会川',35.598453,139.738803], ['大森海岸',35.587695,139.735465], ['平和島',35.579074,139.734996], ['大森町',35.572622,139.732169], ['梅屋敷',35.567042,139.728341], ['京急蒲田',35.560685,139.723731], ['雑色',35.549911,139.715199], ['六郷土手',35.540893,139.707789], ['京急川崎',35.532833,139.700896], ['八丁畷',35.523113,139.691488], ['鶴見市場',35.51783,139.686592], ['京急鶴見',35.50729,139.678098], ['花月園前',35.500413,139.67301], ['生麦',35.495297,139.666969], ['京急新子安',35.487106,139.65554], ['子安',35.484959,139.645635], ['神奈川新町',35.481462,139.640158], ['仲木戸',35.477312,139.634489], ['神奈川',35.471399,139.627467], ['横浜',35.466188,139.622715]] #駅ごとのマックを地図につける for kk_eki in kk_ekis: folium.Marker([kk_eki[1], kk_eki[2]], popup=kk_eki[0]).add_to(map_) map_

- 投稿日:2020-01-12T23:07:33+09:00

ortoolpyによる最適化問題のとってもシンプルな例

やったこと

「Python実践データ分析100本ノック」を読んでいたら、ortoolpyとpulpを使用した最適化問題が出てきました。

使用したことが無いモジュールであったため、自分の理解のために簡単な例を作りました。詳しくはコード中のコメントを参照。

環境

- python 3.7.4

- ortoolpy 0.2.29

- PuLP 2.0

コード

# 必要なモジュールのインポート from pulp import LpVariable, lpSum, value from ortoolpy import model_min # モデルの定義 model = model_min() # 変数の定義 # v_0 と v_1 という2つの変数を定義。具体的な値は入っていない入れ物。 v_0 = LpVariable("V0") v_1 = LpVariable("V1") # 目的関数の設定 # v_0 + v_1 を最小化したい。 model += lpSum([v_0, v_1]) # 制約条件の追加 # v_0 は2以上 model += v_0 >= 2 # v_1 は3以上 model += v_1 >= 3 # v_0 と v_1 は同じ値 model += v_0 == v_1 # 上の条件から、v_0 = v_1 = 3 となることを期待する。 # 問題を解く model.solve() # 結果の表示 # value(変数名)で、計算結果の値を読みだせる。 print("v_0 : ", value(v_0)) print("v_1 : ", value(v_1)) # v_0 : 3.0 # v_1 : 3.0 # 期待通りの値が得られた。

- 投稿日:2020-01-12T23:05:57+09:00

lambda

先頭を大文字に1l = ['Apple', 'banana', 'orange', 'Strawberry', 'cherry'] def change_words(func, words): for word in words: print(func(word)) def capit_func(word): return word.capitalize() change_words(capit_func, l)先頭を大文字に1の実行結果Apple Banana Orange Strawberry Cherrycapi_func関数は、引数wordの先頭を大文字にする関数である。

これをlambdaを使えば、コード量を減らすことができる。先頭を大文字に2l = ['Apple', 'banana', 'orange', 'Strawberry', 'cherry'] def change_words(func, words): for word in words: print(func(word)) capit_func = lambda word: word.capitalize() change_words(capit_func, l)わざわざ、

capit_funcを定義しないで、

change_words関数の引数に直接書く事も可能で、

更にコード量を減らすことが可能である。先頭を大文字に3l = ['Apple', 'banana', 'orange', 'Strawberry', 'cherry'] def change_words(func, words): for word in words: print(func(word)) change_words(lambda word: word.capitalize(), l)このlambdaは、

ファンクションがcapit_func関数だけでなく、

複数ファンクションが必要な場合に威力を発揮する。複数ファンクションl = ['Apple', 'banana', 'orange', 'Strawberry', 'cherry'] def change_words(func, words): for word in words: print(func(word)) change_words(lambda word: word.capitalize(), l) change_words(lambda word: word.lower(), l)複数ファンクションの実行結果Apple Banana Orange Strawberry Cherry apple banana orange strawberry cherryもし、

lambdaを使わなかったら、複数ファンクション2l = ['Apple', 'banana', 'orange', 'Strawberry', 'cherry'] def change_words(func, words): for word in words: print(func(word)) def capit_func(word): return word.capitalize() def low_func(word): return word.lower() change_words(capit_func, l) change_words(low_func, l)と書かねばならない。

capit_func関数とlow_func関数の2つの関数を定義する事が必要となる。

- 投稿日:2020-01-12T22:16:06+09:00

ArcPyでフィーチャにフィールドを追加する

Pythonコード

AddField.pyimport arcpy # 入力パラメータを確認 arcpy.AddMessage("GetArgumentCount() = {0}".format(arcpy.GetArgumentCount())) for i in range(arcpy.GetArgumentCount()): arcpy.AddMessage("type(GetParameter({0})) = {1}".format(i, type(arcpy.GetParameter(i)))) arcpy.AddMessage("GetParameterAsText({0}) = {1}".format(i, arcpy.GetParameterAsText(i))) inFeatureLayer = arcpy.GetParameter(0) outFeatureClass = arcpy.GetParameter(1) # フィーチャレイヤーをコピー arcpy.CopyFeatures_management(inFeatureLayer, outFeatureClass) # フィールドを追加 arcpy.AddField_management(outFeatureClass, "field1", "DOUBLE", field_alias = "フィールド1") arcpy.AddField_management(outFeatureClass, "field2", "DOUBLE", field_alias = "フィールド2") fields = ["OID@", "SHAPE@X", "SHAPE@Y", "field1", "field2"] # フィールドに値を入力 with arcpy.da.UpdateCursor(outFeatureClass, fields) as cursor: arcpy.AddMessage("入力前のフィールド") for row in cursor: arcpy.AddMessage(row) row[3] = row[1] row[4] = row[2] cursor.updateRow(row) del cursor # 入力後の状態を確認 with arcpy.da.SearchCursor(outFeatureClass, fields) as cursor: arcpy.AddMessage("入力後のフィールド") for row in cursor: arcpy.AddMessage(row) del cursor実行結果

ポリゴンが2つ含まれているフィーチャレイヤーを入力として実行した場合。

GetArgumentCount() = 2 type(GetParameter(0)) = <class 'arcpy._mp.Layer'> GetParameterAsText(0) = テストポリゴン type(GetParameter(1)) = <class 'geoprocessing value object'> GetParameterAsText(1) = D:\GIS\ArcGIS_Project\GeometryTest\GeometryTest.gdb\テストポリゴン_AddField 入力前のフィールド [1, 134.32332180386206, 30.338120870687362, None, None] [2, 144.42135929631993, 39.08930527833865, None, None] 入力後のフィールド [1, 134.32332180386206, 30.338120870687362, 134.32332180386206, 30.338120870687362] [2, 144.42135929631993, 39.08930527833865, 144.42135929631993, 39.08930527833865]リファレンス

- 投稿日:2020-01-12T22:15:57+09:00

pythonで16進数を10進数に変換するプログラムを作成してみた

pythonの学習のため16進数を10進数に変換するプログラムを作成してみました。

下記のようにint関数を使えば一発で変換できるので、あくまでも学習です。

main.pyprint(int('3b',base=16))terminal59実際に作成したコードは下記の感じです。

main.pybase_num = '0123456789ABCDEF' count_num = 3 def hex_to_int(hex_str):# HEX文字列を数値へ変換 i = len(hex_str) value = 0 digits = 0 while i > 0: value += base_num.find(hex_str[i - 1]) * (len(base_num) ** digits) i -= 1 digits += 1 return value if __name__ == "__main__": num_list = [] while len(num_list) < count_num: input_num = input('16進数を入力してください:') input_num = input_num.upper() # HEX文字列チェック is_num_check = True for num in input_num: if not num in base_num: is_num_check = False if is_num_check: input_val = hex_to_int(input_num) num_list.append(input_val) else: print('16進数ではありません') print(*num_list)入力した16進数の値を10進数に変換して返します。

内包表記を使えばもっと短く書けそうです。

- 投稿日:2020-01-12T21:41:43+09:00

デコレーター2

2つのデコレーター1def print_more(func): def wrapper(*args, **kwargs): print('func:', func.__name__) print('args:', args) print('kwargs:', kwargs) result = func(*args, **kwargs) print('result:', result) return result return wrapper def print_info(func): def wrapper(*args, **kwargs): print('start') result = func(*args, **kwargs) print('end') return result return wrapper @print_info @print_more def add_num(a, b): return a + b r = add_num(10, 40) print(r)2つのデコレーター1の実行結果start func: add_num args: (10, 20) kwargs: {} result: 30 end 30@print_info と @print_more の順番を入れ替えると

実行結果は入れ替えた場合の実行結果func: wrapper args: (10, 40) kwargs: {} start end result: 50 50となる

これは、

下記の様に

@を使わない書き方でかくと少しは分かりやすいかも。。。2つのデコレーター2def print_more(func): def wrapper(*args, **kwargs): print('func:', func.__name__) print('args:', args) print('kwargs:', kwargs) result = func(*args, **kwargs) print('result:', result) return result return wrapper def print_info(func): def wrapper(*args, **kwargs): print('start') result = func(*args, **kwargs) print('end') return result return wrapper def add_num(a, b): return a + b f = print_info(print_more(add_num)) r = f(10, 40) print(r)2つのデコレーター2の実行結果start func: add_num args: (10, 20) kwargs: {} result: 30 end 30print_info で print_more を包み込むイメージ。。。

- 投稿日:2020-01-12T21:41:30+09:00

Flask-SQLAlchemy + PostgreSQLでWebサービスを作成する

Flask-SQLAlchemy + PostgreSQLでWebサービスを作成する

はじめに

サンプルアプリ(Feedback)を用いてご紹介します。

Mac環境の記事ですが、Windows環境も同じ手順になります。環境依存の部分は読み替えてお試しください。目的

この記事を最後まで読むと、次のことができるようになります。

No. 概要 キーワード 1 Flask-SQLAlchemyの開発 Flask-SQLAlchemy, psycopg2 2 PostgreSQLの設定 psql, Flask-Migrate 実行環境

環境 Ver. macOS Catalina 10.15.2 Python 3.7.3 Flask-Migrate 2.5.2 Flask-SQLAlchemy 2.4.1 Flask 1.1.1 psycopg2 2.8.4 requests 2.22.0 ソースコード

実際に実装内容やソースコードを追いながら読むとより理解が深まるかと思います。是非ご活用ください。

関連する記事

0. 開発環境の構成

tree.sh/ ├── app │ ├── __init__.py │ ├── config.py │ ├── feedback │ │ ├── __init__.py │ │ ├── common/ │ │ ├── models │ │ │ ├── __init__.py │ │ │ └── feedback.py │ │ ├── static/ │ │ ├── templates/ │ │ └── views/ │ ├── run.py │ └── tests/ └── instance ├── postgresql.py ├── sqlite3.py └── config.py1. Flask-SQLAlchemyの開発

パッケージのインストール

パッケージをインストールする。

procedure.sh~$ pip install Flask-Migrate ~$ pip install Flask-SQLAlchemy ~$ pip install Flask ~$ pip install psycopg2

psycopg2のインストールでエラーが出る場合は、環境変数を指定してコマンドを実行する(macOS + venv環境)。procedure.sh~$ xcode-select --install ~$ env LDFLAGS="-I/usr/local/opt/openssl/include -L/usr/local/opt/openssl/lib" pip install psycopg2SQLAlchemyの設定

開発環境のコンフィグを設定する。

config.py"""instance/config.py """ from instance.postgresql import SQLALCHEMY_DATABASE_URI as DATABASE_URI DEBUG = True # SECRET_KEY is generated by os.urandom(24). SECRET_KEY = '\xf7\xf4\x9bb\xd7\xa8\xdb\xee\x9f\xe3\x98SR\xda\xb0@\xb7\x12\xa4uB\xda\xa3\x1b' STRIPE_API_KEY = '' SQLALCHEMY_DATABASE_URI = DATABASE_URI SQLALCHEMY_TRACK_MODIFICATIONS = True SQLALCHEMY_ECHO = TruePostgreSQLを設定する。

postgresql.py"""instance/postgresql.py """ SQLALCHEMY_DATABASE_URI = 'postgresql+psycopg2://{user}:{password}@{host}/{name}'.format(**{ 'user': 'nsuhara', 'password': 'nsuhara', 'host': '127.0.0.1', 'name': 'db.postgresql' })SQLite3を設定する(おまけ)。

sqlite3.py"""instance/sqlite3.py """ import os SQLALCHEMY_DATABASE_URI = 'sqlite:///{host}/{name}'.format(**{ 'host': os.path.dirname(os.path.abspath(__file__)), 'name': 'db.sqlite3' })Modelの作成

SQLAlchemyのインスタンスを生成する。

__init__.py"""app/feedback/models/__init__.py """ from flask_sqlalchemy import SQLAlchemy db = SQLAlchemy() def init(): """init """ db.create_all()SQLAlchemyのクラス(

db.Model)を継承してModelを作成する。feedback.py"""app/feedback/models/feedback.py """ from datetime import datetime from feedback.models import db class Feedback(db.Model): """Feedback """ __tablename__ = 'feedback' id = db.Column(db.Integer, primary_key=True, autoincrement=True) service = db.Column(db.String(255), nullable=False) title = db.Column(db.String(255), nullable=False) detail = db.Column(db.String(255), nullable=False) created_date = db.Column( db.DateTime, nullable=False, default=datetime.utcnow) def __init__(self, service, title, detail): self.service = service self.title = title self.detail = detail def to_dict(self): """to_dict """ return { 'id': self.id, 'service': self.service, 'title': self.title, 'detail': self.detail, 'created_date': self.created_date }2. PostgreSQLの設定

Homebrewの実行例となります。サービスの確認

サービスを確認する。

procedure.sh~$ brew services listexample.shName Status User Plist postgresql started nsuhara /Users/nsuhara/Library/LaunchAgents/homebrew.mxcl.postgresql.plistサービスの開始/終了

サービスを開始する。

procedure.sh~$ brew services start postgresqlサービスを終了する。

procedure.sh~$ brew services stop postgresqlデータベースの確認

データベースを確認する。

デフォルトで3つのデータベースが作成される。また、Macのユーザ名がOwnerとして設定される。procedure.sh~$ psql -lresult.shList of databases Name | Owner | Encoding | Collate | Ctype | Access privileges --------------+---------+----------+---------+-------+--------------------- postgres | nsuhara | UTF8 | C | C | template0 | nsuhara | UTF8 | C | C | =c/nsuhara + | | | | | nsuhara=CTc/nsuhara template1 | nsuhara | UTF8 | C | C | =c/nsuhara + | | | | | nsuhara=CTc/nsuharaデータベースの接続/切断

データベースに接続する。

procedure.sh~$ psql -h "<host_name>" -p <port_number> -U "<role_name>" -d "<database_name>"example.sh~$ psql -h "127.0.0.1" -p 5432 -U "nsuhara" -d "postgres"データベースの接続を切断する。

procedure.shpostgresql=# \qロール(ユーザ)の作成

データベースに接続する。

ロール(ユーザ)を確認する。

procedure.shpostgresql=# \duresult.shList of roles Role name | Attributes | Member of ----------+------------------------------------------------------------+----------- nsuhara | Superuser, Create role, Create DB, Replication, Bypass RLS | {}ロール(ユーザ)を作成する。

procedure.shpostgresql=# CREATE ROLE "<role_name>" LOGIN PASSWORD "password";example.shpostgresql=# CREATE ROLE "nsuhara" LOGIN PASSWORD "nsuhara";ロール(ユーザ)を削除する。

procedure.shpostgresql=# DROP ROLE "<role_name>";example.shpostgresql=# DROP ROLE "nsuhara";データベースの作成

データベースに接続する。

データベースを確認する。

procedure.shpostgresql=# \lresult.shList of databases Name | Owner | Encoding | Collate | Ctype | Access privileges --------------+---------+----------+---------+-------+--------------------- db.postgresql | nsuhara | UTF8 | C | C | postgres | nsuhara | UTF8 | C | C | template0 | nsuhara | UTF8 | C | C | =c/nsuhara + | | | | | nsuhara=CTc/nsuhara template1 | nsuhara | UTF8 | C | C | =c/nsuhara + | | | | | nsuhara=CTc/nsuharaデータベースを作成する。

procedure.shpostgresql=# CREATE DATABASE "<database_name>" OWNER "<role_ name>";example.shpostgresql=# CREATE DATABASE "db.postgresql" OWNER "nsuhara";データベースを削除する。

procedure.shpostgresql=# DROP DATABASE "<database_name>";example.shpostgresql=# DROP DATABASE "db.postgresql";データベースのマイグレーション

Flaskの環境変数を設定する。

データベースをマイグレートする。

procedure.sh~$ flask db init ~$ flask db migrate ~$ flask db upgrade

- 投稿日:2020-01-12T21:28:13+09:00

日本語を駅名に変換するプログラム

初めに

みなさまは駅名替え歌というものをご存じでしょうか。youtubeなどで探せばすぐに出てくると思います。

歌の歌詞をすべて存在する駅名にするというものです。最初に聴いたときはその再現度の高さに驚きました。

見たところ皆さん自作されているように見受けられたので、「これプログラムできるくない?」と思い、作成にとりかかった次第です。環境

本件はローカルで作成しました。

- Window 10

- Python 3.8.1

画面

機能

一番上のテキストエリアに日本語を入力して変換ボタンを押すと、入力された文字列が駅名に変換され、中段に漢字、下段にひらがなで表示されます。

今後の課題

- Githubの使い方を学習して当プログラムを公開する

- ひらがな・カタカナしか対応していないので漢字も対応できるようにする

- 変換された文字列に「語感の近さ」を与えて、それっぽい駅名を出力するようにする

- 見た目をかっこよくする(優先度低)

- LINEのAPI連携とかAndroidアプリとか...(優先度低)

所感

見た目に時間かけなくていいなと思ったのでhtmlとbootstrapで最小限の実装をしています。

できる人は最小限でもおしゃれなんだろうな...

ニーズのないサービスに価値はなかったです。

- 投稿日:2020-01-12T21:24:21+09:00

ケンブリッジ大学による機械翻訳アーキテクチャ概論 by Slack翻訳アプリKiara

はじめに

2019年の機械翻訳の進化が非常に良くまとまったケンブリッジ大学の論文があったのでご紹介します。

弊社は自社でSlack向けの翻訳Chatbot Plugin、Kiaraを開発しており、

日本初のSlack Developer Chapter Leaderとしてリードエンジニア原田が頑張っております。

https://kiara-app.com/ (無料お試し版あり)

Slackと働き方革命に対するパッションから、今後も開発者コミュニティを盛り上げてまいります。Abstract

Neural Machine Translation: A Review

(Submitted on 4 Dec 2019)

The field of machine translation (MT), the automatic translation of written text from one natural language into another, has experienced a major paradigm shift in recent years. Statistical MT, which mainly relies on various count-based models and which used to dominate MT research for decades, has largely been superseded by neural machine translation (NMT), which tackles translation with a single neural network. In this work we will trace back the origins of modern NMT architectures to word and sentence embeddings and earlier examples of the encoder-decoder network family. We will conclude with a survey of recent trends in the field.機械翻訳(MT)、ある自然言語から別の自然言語への文章の自動翻訳の分野は、近年大きなパラダイムシフトを経験しています。主にさまざまなカウントベースのモデルに依存し、数十年間MT研究を支配していた統計MTは、単一のニューラルネットワークで翻訳に取り組むニューラル機械翻訳(NMT)にほぼ取って代わられました。この作業では、最新のNMTアーキテクチャの起源を、単語と文の埋め込み、およびエンコーダ/デコーダネットワークファミリの以前の例にまでさかのぼります。最後に、この分野の最近の傾向を調査します。

https://arxiv.org/abs/1912.02047

Conclusion

Neural machine translation (NMT) has become the de facto standard for large-scale machine translation in a very short period of time. This article traced back the origin of NMT to word and sentence embeddings and neural language models. We reviewed the most commonly used building blocks of NMT architectures – recurrence, convolution, and attention – and discussed popular concrete architectures such as RNNsearch, GNMT, ConvS2S, and the Transformer.

We discussed the advantages and disadvantages of several important design choices that have to be made to design a good NMT system with respect to decoding, training, and segmentation. We then explored advanced topics in

NMT research such as explainability and data sparsity.主要箇所 Main Topic

NMT=Neural Machine Translation

Word Embeddings

Phrase Embeddings

Sentence Embeddings

Encoder-Decoder Networks

Attentional Encoder-Decoder Networks

Recurrent NMT

Convolutional NMT

Self attention based NMT

Search problem in NMT

Greedy and beam search

Decoding direction

Generating diverse translation

Simultaneous translation

Open vocabulary NMT

NMT model errors

Reinforcement learning

Adversarial training

Explainable NMT

Multilingual NMT

- 投稿日:2020-01-12T21:18:13+09:00

アンパンマン画伯判別機を作ってみた

はじめに

AIを勉強して学んだ技術で簡単なアプリを作ってみようと思い、

以下のようなものを作ってみました。

何故アンパンマンにしたかというと、簡単に書ける漫画キャラという事で選びました。

モデルはGANを扱ってみたかったのと、正常画像のみの学習で異常検知ができるという事で

ANOGANにしようと思いましたが、調べてみるとANOGANの高速版でEfficientGANという

ものがあるらしいので、それにしました。

また、シンプルにするためアンパンマンの顔だけを判別する前提で作成しました。流れ

1. AIにアンパンマンの正常画像を学習させる。

2. 正常画像群と異常画像群をAIに入力し、それぞれのスコアの平均の中間値を

異常画像を判別する閾値に設定。

3. 実際に手書き画像を入力し、AIにその絵が異常かどうか判別させる。やったこと

データセット作成

・学習用画像

ネットからスクレイピングでアンパンマン画像を集め、画像を加工して顔だけ切り取りました。

また後述の通り携帯撮影画像の背景がグレーになっていたので、背景も学習させるため

下記関数を用いて、グレーのグラデーションのデータ拡張を行いました。from PIL import Image, ImageOps import numpy as np def make_gray_gradation(img, gradation_range=(230, 255)): """ 入力画像の背景をランダムな度合いのグレイグラデーションに変換する Input : 画像ファイル(カラーでも可) Output : 画像ファイル(背景がグレイグラデーション変換された画像) Pramater img : 入力画像 gradation_range : グラデーションするRGB値の範囲 """ gra_range = np.random.randint(*gradation_range) gray = ImageOps.grayscale(img) output = ImageOps.colorize(gray, black=(0, 0, 0), white=(gra_range, gra_range, gra_range)) return output・正常画像群と異常画像群

正常画像は、イラスト画像を透かして画用紙に書いたアンパンマンと、

私と学友が書いたアンパンマンを携帯で撮影した画像を用いました。異常画像は、バイキンマンやドキンちゃん等のイラスト画像を上記同様に携帯で撮影した画像と

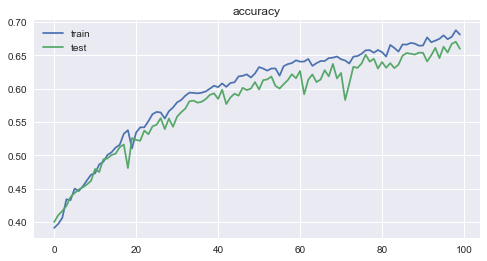

ネットでスクレイピングした下手なアンパンマン画像を用いました。学習後、正常画像群と異常画像群の入力、生成画像比較、スコア分布

携帯で撮影した入力画像の背景がグレーになっていたので、学習用画像にグレーのグラデーションも

入れたのですが、うまく再現できませんでした。

スコアもアンパンマンの絵がうまく書けているかよりも、背景がうまく生成できているかどうかで

決まっているようで、異常画像を判別するための閾値がうまく決まりませんでした。対策 2値化

対策として、すべての画像について背景は全て真っ白にして、絵の輪郭がアンパンマンに似ているかだけで

異常な絵かどうか判別できるようにしました。以下は入力画像を2値化する関数です。import os import scipy.stats as stats from PIL import Image def image_binarization(path_in, path_out, th_zero_num=1400, width=100, height=100): """ 入力画像の輪郭を白黒で2値化して出力する。 Input : 画像ファイルが保存されているフォルダパス(終わりは/) (フォルダには画像以外入れない) Output : 2値化後の画像を指定フォルダに保存。 2値化後の0(輪郭線)のドット数を出力。 Pramater path_in : 入力画像群が入ったディレクトリパス path_out : 出力ディレクトリパス th_zero_num : 画像の0(輪郭線)のドット数のMIN値(輪郭が濃過ぎる時は小さくして調整) width : 画像の横幅サイズ height : 画像の縦幅サイズ """ list_in = os.listdir(path_in) im_np_out = np.empty((0, width*height)) for img in list_in: path_name = path_in+img x_img = cv2.imread(path_name) x_img = cv2.resize(x_img, (width, height)) x_img= cv2.cvtColor(x_img, cv2.COLOR_BGR2GRAY) x_img = np.array(x_img) x_img = x_img / 255.0 x_img = x_img.reshape((1, width, height)) x_img = x_img.reshape(1, width*height) m = stats.mode(x_img) max_hindo = m.mode[0][0] for c in reversed(range(50)): th = (c+1)*0.01 th_0_1 = max_hindo-th x_img_ = np.where(x_img>th_0_1, 1, 0) if (np.count_nonzero(x_img_ == 0))>th_zero_num: break display(np.count_nonzero(x_img_ == 0)) x_img = x_img_.reshape(width, height) x_img = (x_img * 2.0) - 1.0 img_np_255 = (x_img + 1.0) * 127.5 img_np_255_mod1 = np.maximum(img_np_255, 0) img_np_255_mod1 = np.minimum(img_np_255_mod1, 255) img_np_uint8 = img_np_255_mod1.astype(np.uint8) image = Image.fromarray(img_np_uint8) image.save(path_out+img, quality=95)対策後、正常画像群と異常画像群の入力、生成画像比較、スコア分布

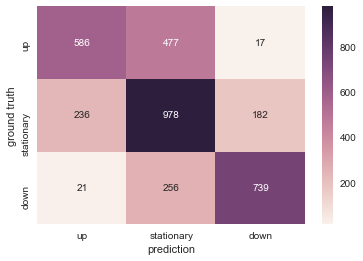

正解画像と異常画像で、ある程度スコアの分布が分かれましたので、とりあえずざっくりと

正常、異常を分ける閾値を決められそうです。(閾値は0.40372に決められていました)入力したアンパンマン画像が正常な絵か、異常な絵か判別

入力画像

5枚だけイラスト画像を透かして書いたアンパンマン画像を入力し、

他はネットでスクレイピングした下手なアンパンマンを14枚を入力しました。

(上記の2値化関数を用いて2値化してから入力)判別結果

判別結果はスコア表示枠の背景の色で表されます。背景が青なら正常画像、赤なら異常画像です。

結果は、イラストを透かしたアンパンマンは4/5が正常判定。

他のスクレイピングした下手なアンパンマンは8/14が異常判定で

正解率12/19=63.15%でした。もっと精度上げないといけないですね。学んだこと

・真っ白な画用紙に描いた絵を撮影したにもかかわらず、実際の画像は背景がグレーだったので

光の影響の大きさを感じたとともに、2値化等やり方を工夫して、より学習しやすい条件に限定する事で

精度を向上出来る事を学びました。

・GANの精度を向上させるために、GrobalAvaragePoolingやLeakyReLuやレイヤーにノイズを入れる等

いろいろ精度向上手法を試せたのが良かったと思います。(結果はあまり改善しませんでしたが)今後

GANの精度向上策をもっといろいろ調べて試していきたいですね。

また、GoogleColabやAWSのEC2を使用していたのですが、今後AWSのSageMakerやGCP等いろいろな

クラウドを使用して勉強していきたいと思っています。コード