- 投稿日:2019-08-19T23:20:39+09:00

Pythonのクラスやインスタンスをおさらいしよう

はじめに

未来電子テクノロジーでインターンをしている宮﨑です。

Pythonの基礎であるクラスとメソッドを再確認するためにまとめたいと思います。

もし誤りがあれば修正するのでどんどん指摘してください。語句説明

クラス・・・設計図や型のようなもの。カテゴリー(動物、フルーツなど)のように実体はない。

インスタンス・・・設計図をもとに作られる「もの」。一つのクラスから複数のインスタンスを作れる。

メソッド・・・クラスの中で定義した関数(処理のまとまり)のこと。書き方の流れ

クラスを用意する

クラス名をclassの後に書く。

class クラス名:メソッドをクラスに追加する

メソッド名をdefの後に書く。

メソッドの第一引数には、それぞれのインスタンス自身を示すselfを追加する。#(例) def info(self): print(self.name)(補足)コンストラクタ

インスタンスを生成した時に、自動的に呼び出すメソッドのことをコンストラクタといい、そのうちインスタンスを初期化するメソッドとして

__init__を使う。

__init__の他には、インスタンスを作るときに呼ばれるメソッド__new__もある。クラスからインスタンスを作成

クラス名()でインスタンスを生成でき、インスタンスを変数に代入する。変数名=クラス名()メソッドを呼び出す

どのインスタンスに対してメソッドを呼び出すのかを明らかにするために、メソッド名の前にインスタンス名をつける。

インタンス名.メソッド名()具体例

#クラスの生成 class Fruit: #コンストラクタの生成 def __init__(self,name): self.name = name #メソッドの生成 def info(self): print(self.name + "です。") #インスタンスの生成 apple = Fruit("リンゴ") #メソッドの呼び出し apple.info() #「リンゴです」と出力されるまとめ

今回は、Pythonのクラスやインスタンスについてまとめました。

何気なく使っているものも、再確認してみるとより使いやすくなるのではないでしょうか。

- 投稿日:2019-08-19T23:08:12+09:00

Yolov3+ROS+Jetsonnanoで作るじゃんけんゲーム

モチベーション

とある家族見学会のイベントで、子供も楽しめるゲームを作ろうと思い立ちました。

子供も楽しめるものといえばじゃんけん…という安易な発想から、カメラ1台でじゃんけんの出し手を認識して勝ったらお菓子を進呈する装置を作ってみました。

今回は、物体検出アルゴリズムとしてYolov3を、動作させる環境としてJetsonNano+ROSの組み合わせで実装しました。

(じゃんけん画像認識自体はすでに色々な方が試行されていますが、ここではYolo・Jetson・ROSという色々と応用が効きそうな方法のお試しも兼ねてやっています。)この記事の中で触れること

- データセットの作成

- Yolov3の学習

- JetsonNanoへの実装

すべての手順について詳細に触れられるわけではありませんが、ポイントになりそうなところを掻い摘んで説明できればと思います。誰かのお役に立てれば。

データセットの作成

一般的にはDeeplearningベースの物体認識では数千枚オーダーのデータセットが必要になってきます。

精度の良い物体検出モデルを作るためには、いろいろな姿勢・背景の手を含む写真を集めてアノテーション(どこにどのポーズの手が写っているかマークする作業)を行う必要があります。画像収集やアノテーションの作業をゼロからやるのはとても大変です。

なんとか手抜きをする方法がないかWebを探して見たところ、じゃんけんを画像認識で実装しているドンピシャな記事を見つけました。

こちらの記事では、画像に写っている手のポーズを推定する(Classification)タスクを扱っていますが、今回は手のポーズに加えてその位置も推定する(Detection)タスクで実装します。上でご紹介した記事では、トルコの高校生の方々が作ったデータセットを使っていますが、ここでもそのデータセットを活用します。

Sign-Language-Digits-Datasetは、0〜9を表す手のポーズをそれぞれおよそ200枚ずつ保持しています。今回は、グー・チョキ・パーがわかればよいので0・2・5の三クラス分のデータを利用します。

このデータセットはそれぞれの写真とそのクラス番号の情報しかありませんが、物体検出の学習を行えるようにするために、どうにかして手の領域をアノテーションしてあげる必要があります。また、白背景だけではなく色々な種類の背景を生成して、よりロバストなモデルを作りたいと思います。

今回のデータセット生成の流れは下記の通りです。

- 手の領域を切り抜いた画像を生成する

- データオーグメンテーション

- 結合された画像に対応するアノテーションデータを自動生成する

手の領域切り抜き

手の領域の切り抜き方法として、安易ではありますがOpenCVの色域抽出機能を使いました。

Sign-Language-Digits-Datasetでは背景が白であるため、下記のように切り抜き自体は比較的うまくいきました。左から元画像、色域抽出によるマスク領域、元画像からマスク領域のみを切り抜いた画像です。元画像には、マスク領域をもとに外接矩形を描画しています。色域抽出に使ったコードはこちら。

def colorRange(hsvImg): HSV_MIN = np.array([0, 20, 40]) HSV_MAX = np.array([20, 220, 255]) hsv_mask = cv2.inRange(hsvImg, HSV_MIN, HSV_MAX) kernel = np.ones((2,2),np.uint8) ksize=5 hsv_mask = cv2.medianBlur(hsv_mask,ksize) hsv_mask = cv2.morphologyEx(hsv_mask, cv2.MORPH_CLOSE, kernel) hsv_mask = cv2.dilate(hsv_mask,kernel,iterations = 1) return hsv_maskデータオーグメンテーション

前項で切り抜かれた手の画像に、色々と手を加えてデータオーグメンテーションをしていきます。

目的は、色々な条件下の画像に反応できるようにするためです。

今回は色々な背景に対応できるようなモデルを作る必要があるため、データセットにも色々な背景を含めてあげる必要があります。

とはいえ、背景の画像を収集するのが面倒だったのでまずはガウシアンノイズを使って背景を埋めてみることにしました。ついでに、元画像を3方向に回転させて合成します。禍々しいね。ガウシアンノイズを加えるために使ったコードはこちら。

def addGaussianNoise(src): row,col,ch= src.shape mean = 0 var = 0.5 sigma = 50 gauss = np.random.normal(mean,sigma,(row,col,ch)) gauss = gauss.reshape(row,col,ch) a=1 noisy = a*src + (4-a)*gauss return noisyちなみに、画像は下記のようにして回転させて合成しています。

def augmentedImage(img): orgH, orgW = img.shape[:2] aImg = np.zeros((orgH*2, orgW*2, 3), np.uint8) aImg[0:orgH,0:orgW] = img #90度 transpose_img = img.transpose(1,0,2) clockwise = transpose_img[:,::-1] aImg[orgH:orgH*2,0:orgW] = clockwise #-90度 counter_clockwise = transpose_img[::-1] aImg[0:orgH,orgW:orgW*2] = counter_clockwise #180度 xAxis = cv2.flip(img, 0) yAxis = cv2.flip(img, 1) xyAxis = cv2.flip(img, -1) aImg[orgH:orgH*2,orgW:orgW*2] = xyAxis return aImg結論から言うと、ガウシアンノイズだけでは背景のオーグメンテーションとして不十分だったので下記のようにWeb上の画像を追加で合成しています。禍々しいね(2回目)。

背景の画像は、こちらのサイトのものをお借りしました。

処理を抜粋するとこんな感じです。backgroundDirの中に背景画像を入れておいて、ランダムに選択・切り抜きした上で100×100のサイズにリサイズしています。backgroundFiles = [r for r in glob.glob(backgroundDir)] bgImg = cv2.imread(random.choice(backgroundFiles)) n = int(random.randint(-10, 10)*15) bgImg = bgImg[300+n:500+n, 200+n:400+n] bgImg = cv2.resize(bgImg, (100, 100))更に、学習と推論を試して見ると子供の手にうまく反応できないことがわかってきました。

どうも、大人と子供の手の大きさや指長さが影響しているようです。

手前味噌ではありますが、アフィン変換で画像を圧縮(つぶして)画像生成しました。縦の長さの30%くらいを圧縮しています。禍(以下略)処理は下記のような感じで。

def pressImage(img, ratio): ratio = 1.0 - ratio orgH, orgW = img.shape[:2] src_pts = np.array([[0, 0], [int(orgW/2), 0], [orgW, orgH]], dtype=np.float32) dst_pts = np.array([[0, int(orgH*ratio)], [int(orgW/2),int(orgH*ratio)], [orgW, orgH]], dtype=np.float32) mat = cv2.getAffineTransform(src_pts, dst_pts) #print(mat) affine_img = cv2.warpAffine(img, mat, (orgW, orgH)) return affine_imgアノテーションデータの生成

前の章で説明したマスク画像を生成した時点で手の領域の座標がわかるので、その情報を使ってアノテーションデータを生成します。下記のようにマスク画像(maskImg)をもとに、外接矩形を検索します。

ここでは、元画像に手が一つしか写っていない前提で最も大きな矩形を選び出しています。dst, contours, hierarchy = cv2.findContours(maskImg, cv2.RETR_TREE, cv2.CHAIN_APPROX_SIMPLE) for i, contour in enumerate(contours): area = cv2.contourArea(contour) if area < size_min: continue if image_size * 0.99 < area: continue x,y,w,h = cv2.boundingRect(contour) if w*h > size_max: size_max = w*h maxX,maxY,maxW,maxH = x,y,w,h各画像ごとにグー、チョキ、パーが写っている座標をアノテーションファイルとして出力すれば学習の準備は完了。

YOLOv3の学習

ここまでで作成したデータセットをもとに、YOLOv3(darknet)を使って学習を進めます。

詳細な手順は各所で紹介されていますので省略しますが、今回は推論速度を優先してtiny-yoloを使っています。

学習時、標準出力にログが表示されます。

バッチサイズを128で設定しているため、128枚の画像を学習するごとにlossやlearning rateなどの情報が出力されます。Region 23 Avg IOU: -nan, Class: -nan, Obj: -nan, No Obj: 0.538939, .5R: -nan, .75R: -nan, count: 0 Region 16 Avg IOU: 0.276084, Class: 0.366372, Obj: 0.541348, No Obj: 0.476522, .5R: 0.218750, .75R: 0.000000, count: 32 Region 23 Avg IOU: -nan, Class: -nan, Obj: -nan, No Obj: 0.539579, .5R: -nan, .75R: -nan, count: 0 1: 485.622101, 485.622101 avg, 0.000000 rate, 3.699675 seconds, 128 imagesavgで表示されているloss、rateで表示されている学習率を縦軸に、イテレーション数を横軸にグラフを書くと下のような感じになります。学習率はデフォルトで0.001を目指すように設定されていますが、今回は1000イテレーション付近ですでにサチっています。

出来上がったモデルとしては、100000イテレーション付近のものがうまく手に反応できていたのでそれを使いましたが、各種ハイパーパラメータはチューニングの余地ありかと思います。

Jetson Nanoへの実装

出来上がったモデルを動作させる環境として、流行りのJetson Nanoを使って見ました。

1万円ちょっと出して強力かつ小型のGPUマシンが手に入るとは、良い時代になりましたね。ケースには、Thingiverseで配布されているものを出力して利用しました。

セットアップについてはからあげさんの記事で詳細に説明されておりますので、そちらを参考にしています。

構成はこちらの通り。

- Jetson Nano(Jetpack4.2.1)

- Logicool C270(USB-Webカメラ)

- IODATA WN-G300UA(USB Wi-FIモジュール)

- ROS melodic

- darknet_ros(darknetのROS向けラッパー)

- usb_cam(UVCカメラドライバ)

ハードウェア類は、特にドライバインストールせずに動作しました。

またGPUをフルに活用するため、ここではPower Mode: MAXNで動作させます。

microUSBでは電力が不足するため、DCジャックから給電できるようにします。また、ファンも取り付けておきました。ちなみに、現在のPower Modeは”nvpmodel -q”で確認できます。

darknet_rosは公式のGitから、usb_camについてはaptでインストールすることができます。

Jetpack4.2.1では、公式の手順から特に変えることなくインストールできました。sudo apt install ros-melodic-usb-cam続いて、darknet_rosを使った推論実行について説明します。

darknet_rosをオリジナルの学習済みモデルにて使う際に作成、変更が必要な設定ファイルは下記の通りです。(ROSのワークスペースを”~/catkin_ws”に作成していると仮定)

- ~/catkin_ws/src/darknet_ros/darknet_ros/config/ros.yaml

- Subscribeするカメラ画像トピックの名前などを指定

- ~/catkin_ws/src/darknet_ros/darknet_ros/config/janken-yolov3-tiny.yaml

- 学習済みモデルと設定ファイル(weights,cfg)や表示時の閾値、クラス名を定義

- ~/catkin_ws/src/darknet_ros/darknet_ros/yolo_network_config/cfg/janken-yolov3-tiny-train-3classes.cfg

- 学習済みモデルに対応する設定ファイル。入力画像サイズもここで変えることができる

- そのほか、学習済みモデルは~/catkin_ws/src/darknet_ros/darknet_ros/yolo_network_config/weightsに格納する

ros.yamlについて、usb_camからの出力トピックを受けられるようにするため、subscriberを下記のように記載します。

subscribers: camera_reading: topic: /usb_cam/image_raw queue_size: 1janken-yolov3-tiny.yamlはこんな感じ。

yolo_model: config_file: name: janken-yolov3-tiny-train-3classes.cfg weight_file: name: janken-yolov3-tiny-train-3classes_100000.weights threshold: value: 0.3 detection_classes: names: - gu - tyoki - pajanken-yolov3-tiny-train-3classes.cfgについては、画像の入力サイズを下げて処理速度を向上させます。width,height部分の設定によって、ネットワークへの入力画像サイズを変更できます。最初だけ抜粋するとこんな感じ。

[net] # Testing batch=1 subdivisions=1 # Training #batch=64 #subdivisions=16 width=288 height=288 channels=3 momentum=0.9 decay=0.0005 angle=0 saturation = 1.5 exposure = 1.5 hue=.1推論用にbatch,subdivisionsを1にするのを忘れずに。

usb_camノードとdarknet_rosを同時に起動させるためのlaunchファイル(janken-yolov3-tiny.launch)を用意しました。

<?xml version="1.0" encoding="utf-8"?> <launch> <node name="usb_cam" pkg="usb_cam" type="usb_cam_node" output="screen" > <param name="video_device" value="/dev/video0" /> <param name="image_width" value="640" /> <param name="image_height" value="480" /> <param name="pixel_format" value="yuyv" /> <param name="camera_frame_id" value="usb_cam" /> <param name="io_method" value="mmap"/> </node> <node name="image_view" pkg="image_view" type="image_view" respawn="false" output="screen"> <remap from="image" to="/usb_cam/image_raw"/> <param name="autosize" value="true" /> </node> <!-- Console launch prefix --> <arg name="launch_prefix" default=""/> <!-- Config and weights folder. --> <arg name="yolo_weights_path" default="$(find darknet_ros)/yolo_network_config/weights"/> <arg name="yolo_config_path" default="$(find darknet_ros)/yolo_network_config/cfg"/> <!-- ROS and network parameter files --> <arg name="ros_param_file" default="$(find darknet_ros)/config/ros.yaml"/> <arg name="network_param_file" default="$(find darknet_ros)/config/janken-yolov3-tiny.yaml"/> <!-- Load parameters --> <rosparam command="load" ns="darknet_ros" file="$(arg ros_param_file)"/> <rosparam command="load" ns="darknet_ros" file="$(arg network_param_file)"/> <!-- Start darknet and ros wrapper --> <node pkg="darknet_ros" type="darknet_ros" name="darknet_ros" output="screen" launch-prefix="$(arg launch_prefix)"> <param name="weights_path" value="$(arg yolo_weights_path)" /> <param name="config_path" value="$(arg yolo_config_path)" /> </node> </launch>システムの起動は、下記の通り。シンプルですね。

roslaunch darknet_ros janken-yolov3-tiny.launch起動すると、USBカメラの画像と推論結果を重畳されたものが表示されます。

入力画像サイズを縮小していることもあって、平均して10-12fpsくらいの速度で処理できています。

オーギュメンテーションを頑張った甲斐もあり、背景や手の向きに強くなっています。終わりに…

大変に長くなりましたが、ここまで読んでくださってありがとうございます。

単純な推論だけだったらdarknetを単体で使えばよいのですが、今回はじゃんけんの結果に応じてお菓子(うまい棒)が飛び出てくるマシーンを作ったため、ROSを使った実装にしました。

(rosserialを使ってArduinoを制御し、サーボモーターを動かしてうまい棒を飛ばす)何か皆様の参考になる部分があれば幸いです。

- 投稿日:2019-08-19T22:32:57+09:00

連続ウェーブレット変換を使ってみたかったので離散化して実装した

信号の時間-周波数解析の代表的な手法の1つである、連続ウェーブレット変換を勉強していたのですが、実際にプログラミングで実装するためには離散化しなければなりません1。

ググると離散化した後の数式も見つかったのですが、イマイチよく分からなかったので自分で導出して、さらに実装してみました。主に参考としたのは、I. Daubechies著の「ウェーブレット10講」(丸善出版)です。

かなりしっかりした理論の本ですが、ざっと読んだだけだと途中から訳わかめだったので、時間を取ってじっくり読み直したいです。連続ウェーブレット変換の定義

連続ウェーブレット変換の背景やらは色んなところに載っているのでここでは割愛します。時間信号$x(t)$の連続ウェーブレット変換の式は以下の通り。

X(a, b) = \int_{-\infty}^{\infty} x(t)\,\overline{\psi}_{a, b}(t)\,dt \tag{1.1}\psi_{a, b}(t) = \frac{1}{\sqrt{a}}\,\psi\Bigl(\frac{t - b}{a}\Bigr) \tag{1.2}ここで、$\psi(t)$はマザーウェーブレット、$a$はスケール、$b$は時間シフトです。$\overline{\psi}$は$\psi$の複素共役を表します。

スケール$a$は周波数$f$の逆数に相当し、補正係数$\lambda$を用いて以下のように表せます。a = \frac{\lambda}{f}\tag{1.3}一方で、連続ウェーブレット変換の逆変換は以下の通り。

x(t) = \frac{1}{C_{\psi}}\int_{-\infty}^{\infty} \int_{-\infty}^{\infty} X(a, b) \,\psi_{a, b}(t)\,db\,\frac{da}{a^2} \tag{1.4}$C_{\psi}$はadmissible constantと呼ばれる数で、この値が有限であることが逆変換の存在条件になっています。

C_{\psi} = 2\pi\int_{-\infty}^{\infty}\frac{|\hat{\psi}(\omega)|^2}{|\omega|}d\omega<\infty \tag{1.5}ここで、$\hat{\psi}(\omega)$はマザーウェーブレット$\psi(t)$のフーリエ変換です。

実用上、時間信号$x(t)$は実数である場合がほとんどで、この場合は(1.4)式を以下のように変形できるようです。

x(t) = \frac{2}{C_{\psi}}\int_{0}^{\infty} \int_{-\infty}^{\infty} X(a, b) \,\psi_{a, b}(t)\,db\,\frac{da}{a^2} \tag{1.6}文献によって、(1.5)式の係数の$2\pi$が無かったり2、(1.6)式の係数に$2$が出てこなかったり、記述がバラバラですごく混乱しました…

今回は(1.1)式と(1.6)式を離散化していきます。連続ウェーブレット変換の離散化

時間の離散化

連続ウェーブレット変換を離散信号に適用するためには、時間$t$に関する積分が邪魔なので、時間$t$を離散化していきます。

サンプリング周波数を$f_{s}$として、次式を満たす実数$n$を定めます。\begin{align} t &= \frac{n}{f_{s}}\\ &= n\Delta t\tag{2.1.1} \end{align}積分変数の置換のために微分しときます。

\frac{dt}{dn} = \Delta t \tag{2.1.2}この時、時間信号$x(t)$をサンプリングした信号$x[n]$は以下のように表せます。

x[n] = x\Bigl(\lfloor\frac{t}{\Delta t}\rfloor \Delta t \Bigr) \tag{2.1.3}ここでウェーブレットも離散化しておきます。

\psi_{a, b}[n] = \psi_{a, b}(n\Delta t) = \psi_{a, b}\Bigl(\lfloor\frac{t}{\Delta t}\rfloor \Delta t \Bigr) \tag{2.1.4}(2.1.1)-(2.1.4)式より、(1.1)式は以下のように近似できます。

\begin{align} X(a, b) &= \int_{-\infty}^{\infty} x[n]\,\overline{\psi}_{a, b}[n]\,\Delta t\,dn\\ &= \Delta t\sum_{n=-\infty}^{\infty} x[n]\,\overline{\psi}_{a, b}[n]\tag{2.1.5} \end{align}これで離散信号に対応させることができました。丁寧に書きましたがこれくらいは簡単ですね。

連続ウェーブレット逆変換の離散化

次に逆変換を離散化していきます。こっちが曲者でした。

とりあえず逆変換の式を再掲。x(t) = \frac{2}{C_{\psi}}\int_{0}^{\infty} \int_{-\infty}^{\infty} X(a, b) \,\psi_{a, b}(t)\,db\,\frac{da}{a^2} \tag{1.6}(2.1.3)(2.1.4)式を適用すると以下のようになります。

x[n] = \frac{2}{C_{\psi}}\int_{0}^{\infty} \int_{-\infty}^{\infty} X(a, b) \,\psi_{a, b}[n]\,db\,\frac{da}{a^2} \tag{3.1}時間シフトの離散化

まずは時間シフト$b$の離散化です。

後々の計算のしやすさ等を考えて、時間$t$の離散化と同様に、サンプリング周期$\Delta t$を使って離散化します。具体的には以下の式を満たす実数$m$で表します。b = m \Delta t \tag{3.1.1}同じように微分しときます。

\frac{db}{dm} = \Delta t \tag{3.1.2}(3.1.1)(3.1.2)式を(3.1)式に適用してみましょう。

\begin{align} x[n] &= \frac{2}{C_{\psi}}\int_{0}^{\infty} \int_{-\infty}^{\infty} X(a, m\Delta t) \,\psi_{a, m\Delta t}[n]\,\Delta t\,dm\,\frac{da}{a^2}\\ &= \frac{2\Delta t}{C_{\psi}}\int_{0}^{\infty} \sum_{m=-\infty}^{\infty} X(a, m\Delta t) \,\psi_{a, m\Delta t}[n]\,\frac{da}{a^2} \tag{3.1.3} \end{align}とりあえずこれで時間シフト$b$の離散化は終わりです。

スケールの離散化

次はスケール$a$の離散化です。

時間$t$や時間シフト$b$の離散化は、信号自体をサンプリングしたものと考えればすんなりと出せるのですが、スケール$a$は特に決まりがないので、取り方によってはかなり粗い近似になってしまいます。その辺の妥当性については長くなりそうなので別記事へ。離散化の考え方ですが、(1.3)式の周波数$f$に対して、以下のように実数$l$を定めると逆変換の式が綺麗になって嬉しいです。

f = f_{0}\cdot2^{\frac{l}{l_{0}}} \tag{3.2.1}周波数をオクターブ単位で表現しただけです。ここで$f_{0}$は基準周波数で、$l_{0}$はオクターブ分解能です。

例えば、$f_{0}$を440Hz、$l_{0}$を12とすれば、整数$l$に対し、周波数$f$はピアノの各鍵盤の音の高さ(12平均律)を表します。楽曲の解析にちょうど良い。(1.3)式より、スケール$a$は以下のように表せます。

a = a_{l} = \frac{\lambda}{f_{0}} \cdot 2^{-\frac{l}{l_{0}}} \tag{3.2.2}またまた微分しときます。

\begin{align} \frac{da}{dl} &= \frac{\lambda}{f_{0}} \cdot 2^{-\frac{l}{l_{0}}} \cdot \Bigl(-\frac{\ln 2}{l_{0}}\Bigr)\\ &= -\frac{a\ln 2}{l_{0}} \tag{3.2.3} \end{align}(3.2.2)(3.2.3)式より、(3.1.3)式は以下のように変形できます。

\begin{align} x[n] &= \frac{2\Delta t}{C_{\psi}}\int_{\infty}^{-\infty} \sum_{m=-\infty}^{\infty} X(a_{l}, m\Delta t) \,\psi_{a_{l}, m\Delta t}[n]\, \Bigl(-\frac{a_{l}\ln 2}{l_{0}}\Bigr) \frac{dl}{a_{l}^2}\\ &= \frac{2\ln 2 \cdot \Delta t}{C_{\psi}l_{0}}\int_{-\infty}^{\infty} \frac{1}{a_{l}} \sum_{m=-\infty}^{\infty} X(a_{l}, m\Delta t) \,\psi_{a_{l}, m\Delta t}[n]\,dl\\ &\approx \frac{2\ln 2 \cdot \Delta t}{C_{\psi}l_{0}}\sum_{l=-\infty}^{\infty} \frac{1}{a_{l}} \sum_{m=-\infty}^{\infty} X[l, m] \,\psi_{l, m}[n] \tag{3.2.5} \end{align}最後の行で$X(a_{l}, m\Delta t)$を$X[l, m]$、$\psi_{a_{l}, m\Delta t}[n]$を$\psi_{l, m}[n]$と書き直しました。これでスケール$a$の離散化終わりです。

周波数$f$を対数で取ってあげると綺麗になりますね。音声に適用すれば実用性も兼ね備えて良い感じです。

周波数$f$を線形に取る場合でも、同じように積分変数の置換をしてあげればできるはず3。導出のまとめ

整数$l, m, n$を用いて、周波数$f$、スケール$a$、時間シフト$b$、時間$t$を以下のように離散化しました。

f = f_{0}\cdot2^{\frac{l}{l_{0}}}a = \frac{\lambda}{f}b = m \Delta tt = n\Delta tこの時、連続ウェーブレット変換および逆変換は以下のように離散化できます。

X[l, m] = \Delta t\sum_{n=-\infty}^{\infty} x[n]\,\overline{\psi}_{l, m}[n] \tag{4.1}x[n] = \frac{2\ln 2 \cdot \Delta t}{C_{\psi}l_{0}}\sum_{l=-\infty}^{\infty} \frac{1}{a_{l}} \sum_{m=-\infty}^{\infty} X[l, m] \,\psi_{l, m}[n] \tag{4.2}Pythonで実装

数式を導出できたので実装していきましょう。言語はpython3です。

そもそも、Pythonで連続ウェーブレット変換と逆変換を手軽に扱えるモジュールが見つからなくて、それなら自作してやる!ってのがこの記事の始まりだったりします。

コード全文はGitHubに上げています。マザーウェーブレットの実装

マザーウェーブレットは色んな関数がありますが、今回は以下の式で表されるMorletウェーブレットと呼ばれる関数を使います。

\psi(t) = \frac{C_{\omega_{0}}}{\pi^{1/4}}e^{-\frac{1}{2}t^2}\,(e^{j\omega_{0}t} - e^{-\frac{1}{2}\omega_{0}^2}) \tag{5.1.1}ここで$C_{\omega_{0}}$は以下の式で表されます。

C_{\omega_{0}} = \Bigl(1 + e^{-\omega_{0}^2} - 2e^{-\frac{3}{4}\omega_{0}^2}\Bigr)^{-\frac{1}{2}} \tag{5.1.2}それでは

Morletクラスを実装していきましょう。__init__メソッドはこんな感じ。Morlet.pyimport numpy as np class Morlet(object): def __init__(self, w0=6.0): self.w0 = w0 self.Cw = (1 + np.exp(-self.w0 ** 2) - 2 * np.exp(-0.75 * self.w0 ** 2)) ** (-0.5) self.C = self._get_C() # admissible constantadmissible constantの計算

admissible constantの計算部分のコードは以下の通り。

Morlet.pydef _get_C(self): # calc admissible constant wmax = 1000 dw = 0.01 w = np.arange(-wmax, wmax + 1, dw) Wf = self._get_W_fourier(w) C = 2 * np.pi * dw * np.sum(np.abs(Wf) ** 2 / np.abs(w)) return C def _get_W_fourier(self, w): # calc fourier transform of wavelet k = np.exp(-0.5 * self.w0 ** 2) Wf = self.Cw / np.pi ** 0.25 *\ (np.exp(-0.5 * (w - self.w0) ** 2) - k * np.exp(-0.5 * w ** 2)) return Wfadmissible constantは(1.5)式で表されます。

C_{\psi} = 2\pi\int_{-\infty}^{\infty}\frac{|\hat{\psi}(\omega)|^2}{|\omega|}d\omega<\infty \tag{1.5}解析解を求めることが難しいので、近似解を求めます。

Morletウェーブレットのフーリエ変換は以下のように表せます。\hat{\psi}(\omega) = \frac{C_{\omega_{0}}}{\pi^{1/4}} \bigl(e^{-\frac{1}{2}(\omega - \omega_{0})^2} - e^{-\frac{1}{2}(\omega^2 + \omega_{0}^2)} \bigr) \tag{5.1.3}(1.5)式の被積分関数をプロットしてみると下図のようになります。

今回は積分範囲を$-1000\leqq\omega\leqq1000$としましたが、もっと狭くても大丈夫そうですね。スケールの計算

周波数からスケールへの変換は(1.3)式で求められます。

a = \frac{\lambda}{f}\tag{1.3}スケール$a$に対し、ウェーブレット$\psi(\frac{t}{a})$のフーリエ変換は$a\,\hat{\psi}(a\omega)$となります。このピークを取る角周波数$\omega_{c}$がスケール$a$に対応する角周波数と見なせます。よって、スケール$a$に対応する各周波数$\omega$は以下の式を満たします。

a\omega = \omega_{c} \tag{5.1.4}ここで、$\omega_{c}$は以下の式の解となります4。

\omega_{c} = \frac{\omega_{0}}{1 - e^{-\omega_{0}\omega_{c}}} \tag{5.1.5}逆に周波数$f$に対応するスケール$a$は(5.1.4)式を変形することで求められます。

a = \frac{\omega_{c}}{\omega} = \frac{\omega_{c}}{2\pi f} \tag{5.1.6}よって、(1.3)式の補正係数$\lambda$は次式で表せます。

\lambda = \frac{\omega_{c}}{2\pi}コードに起こすとこんな感じ。

Morlet.pydef freq2scale(self, freq): # calc scales from frequencies. # center freq wf is given by the solution of below: # wf = w0 / (1 - exp(-wf * w0)) # if w0 > 5, wf is nearly equal to w0. w_center = self.w0 for i in range(100): w = w_center w_center = self.w0 / (1 - np.exp(-w * self.w0)) if np.abs(w_center - w) < 1.0e-8: break return w_center / (2 * np.pi * freq)$\omega_{c}$の解析解はやっぱり難しいので、近似解を求めています。これがfor文のところですね。

$\omega_{c}$は$\omega_{0}$に近い値になるので、初期値を$\omega_{0}$としておくといいです。ウェーブレットの計算

ウェーブレットの計算はほぼ数式通りです。

Morlet.pydef _get_W(self, t): # calc wavelet k = np.exp(-0.5 * self.w0 ** 2) W = self.Cw / np.pi ** 0.25 *\ np.exp(-0.5 * t ** 2) * (np.exp(1j * self.w0 * t) - k) # [n, s] return W def get_W(self, t, scale): # calc wavelet at scale s tt = t.reshape([1, -1]) / scale.reshape([-1, 1]) W = self._get_W(tt) / scale.reshape([-1, 1]) ** 0.5 return W連続ウェーブレット変換と逆変換の実装

Morletクラスが少し長くなってしまいましたが、ようやく本番です。

連続ウェーブレット変換と逆変換を行うCWaveletクラスを実装していきましょう。

__init__メソッドはこんな感じ。CWavelet.pyimport numpy as np from .Morlet import Morlet class CWavelet(object): def __init__(self, fs, wavelet='morlet', w0=6.0, window_len=None, freq_range=None): self.fs = fs # sampling frequency self.dt = 1 / self.fs # sampling interval self.n_per_octave = 12 self.window_len = window_len self.n = None self.W = None if wavelet == 'morlet': self.wavelet = Morlet(w0=w0) # Wavelet class else: raise ValueError('Unexpected wavelet: ' + str(wavelet)) if freq_range is None: freq_range = (13.75, self.fs // 2) else: freq_range = (max(0, freq_range[0]), min(self.fs // 2, freq_range[1])) self.freq_period = self.get_freq_period(freq_range) self.scale = self.wavelet.freq2scale(self.freq_period)対数スケールで等分された周波数の計算は

get_freq_periodメソッドで取得しています。CWavelet.pydef _get_freq_log(self, freq_range): # get frequencies spaced at epual intervals on log2 scale. # frequencies on log2 scale are calculated from music keys based on 440Hz. k0 = int(self.n_per_octave * np.log2(freq_range[0] / 440)) # minimum key kn = int(self.n_per_octave * np.log2(freq_range[1] / 440)) # maximum key k = np.arange(k0, kn + 1, dtype=np.float64) freq_period = 440 * 2 ** (k / self.n_per_octave) # frequencies return freq_period def get_freq_period(self, freq_range): freq_period = self._get_freq_log(freq_range) return freq_period連続ウェーブレット変換の実装

(4.1)(4.2)式に従って連続ウェーブレット変換を実装していくわけですが、式の通りに素直に実装してしまうと、スケールの数を$M$、時間長を$N$とした時に、計算量が$O(MN^2)$となってしまいます。

しかし、フーリエ変換を利用した畳み込みを行うことで、この計算量を$O(MN\log N)$に減らすことができます5。

フーリエ変換の畳み込み定理から以下の式が成り立ちます。\int_{-\infty}^{\infty} f(\tau)g(t - \tau)\,d\tau = F^{-1}[\hat{f}(\omega)\hat{g}(\omega)] \tag{5.2.1}ここで、$\hat{f}(\omega)$と$\hat{g}(\omega)$はそれぞれ$f(t)$と$g(t)$のフーリエ変換を表し、$F^{-1}[\cdot]$はフーリエ逆変換を表します。信号処理をやっているとお馴染みの式ですね。連続系で表しましたが、離散系でも成り立ちます。

(5.2.1)式を使うと(4.1)式は以下のように表せます。\begin{align} X_{l} &= \Delta t\sum_{n=-\infty}^{\infty} x[n]\,\overline{\psi}_{l, 0}[n - m]\\ &= \Delta t\sum_{n=-\infty}^{\infty} x[n]\,\overline{\psi'}_{l, 0}[m - n]\\ &= \Delta t \cdot F^{-1}[\hat{x}(\omega) \hat{\overline{\psi'}}_{a, 0}(\omega)] \tag{5.2.2} \end{align}ここで$\psi'[n]$は以下で表されます。

\psi'[n] = \psi[-n] \tag{5.2.3}実際には高速フーリエ変換(FFT)を使うので、適切にパディングしてあげないと巡回畳み込みという別の計算になってしまうことに注意です。

FFTで畳み込みを計算する部分を関数にするとこんな感じ。

fft_convolvedef fft_convolve(x1, x2): if x1.shape[-1] < x2.shape[-1]: x1, x2 = x2, x1 x1_len = x1.shape[-1] x2_len = x2.shape[-1] s1 = np.fft.fft(x1, x1_len) s2 = np.fft.fft(x2, x1_len) y = np.fft.ifft(s1 * s2, x1_len) return y[..., x2_len - 1:]この関数を使って

CWaveletクラスに連続ウェーブレット変換を計算するメソッドを実装します。CWavelet.pydef _transform_via_fft(self, x, strides=1): y = fft_convolve(x[..., np.newaxis, :], self.W[..., ::-1].conj()) return y[..., ::strides] def _transform(self, x, strides=1): y = self._transform_via_fft(x, strides) #y = self._transform_directly(x, strides) # too late return y def _update_W(self, N): # if precomputed wavelet is not available, update wavelet. if self.window_len is None: window_len = 2 * N - 1 else: window_len = self.window_len if self.W is None or self.n is None or window_len != self.n.shape[-1]: self.n = np.arange(-(window_len // 2), (window_len + 1) // 2) self.W = self.wavelet.get_W(self.n * self.dt, self.scale) def transform(self, x, strides=1): self._update_W(x.shape[-1]) y = self.dt * self._transform(x, strides) return y何度もウェーブレット変換を行う場合に毎回ウェーブレットを計算し直すのは無駄なので、

_update_Wメソッドで再利用するか計算し直すか判断するようにしています。逆変換の実装

逆変換の場合にもフーリエ変換による計算量削減が可能で、(4.2)式も(5.2.2)式と同じように変形できます。

\begin{align} x[n] &= \frac{2\ln 2 \cdot \Delta t}{C_{\psi}l_{0}}\sum_{l=-\infty}^{\infty} \frac{1}{a_{l}} \sum_{m=-\infty}^{\infty} X[l, m] \,\psi_{l, 0}[n - m]\\ &= \frac{2\ln 2 \cdot \Delta t}{C_{\psi}l_{0}}\sum_{l=-\infty}^{\infty} \frac{1}{a_{l}} \sum_{m=-\infty}^{\infty} X[l, m] \,\psi'_{l, 0}[m - n]\\ &= \frac{2\ln 2 \cdot \Delta t}{C_{\psi}l_{0}}\sum_{l=-\infty}^{\infty} \frac{1}{a_{l}} F^{-1}[\hat{X_{l}}(\omega) \,\hat{\psi'}_{l, 0}(\omega)] \tag{5.2.4} \end{align}逆変換も

CWaveletクラスに実装するとこんな感じになります。CWavelet.pydef transform_inverse(self, y): self._update_W(y.shape[-1]) xs = fft_convolve(y, self.W) / self.scale.reshape([-1, 1]) coefficient = 2 * np.log(2) * self.dt / self.n_per_octave / self.wavelet.C x = coefficient * np.sum(xs.real, axis=-2) return x使ってみる

実装した

CWaveletクラスを使って実際に連続ウェーブレット変換を計算してみます。

今回はサンプリング周波数を44.1KHzとし、0.5~1.0秒で440Hzのsin波、1.5~2.0秒で880Hz、2.5~3.0秒でで1760Hzのsin波を含む3.0秒の信号を解析します。

テストコードは以下。test.pyimport time import numpy as np import matplotlib.pyplot as plt from wavelet.CWavelet import CWavelet fs = 44100 f = 440 t = np.arange(fs // 2) x = np.zeros(3 * fs, dtype=np.float64) x[fs//2:fs] = np.sin(2 * np.pi * f * t / fs) x[fs + fs // 2:2 * fs] = np.sin(2 * np.pi * 2 * f * t / fs) x[2 * fs + fs // 2:3 * fs] = np.sin(2 * np.pi * 4 * f * t / fs) wavelet = CWavelet(fs) start = time.time() y = wavelet.transform(x, strides=1) end = time.time() print(end - start) fig = plt.figure() ax = fig.add_subplot(111) im = ax.imshow(np.abs(y) ** 2, aspect='auto', origin='lower') ax.set_xticks(np.arange(0, y.shape[1], fs // 2)) ax.set_xticklabels(map(str, np.arange(0, 3, 0.5))) ax.set_yticks(np.arange(0, y.shape[0], 12)) ax.set_yticklabels(map(str, wavelet.freq_period[::12])) ax.set_xlabel('Time [s]') ax.set_ylabel('Frequency [Hz]') plt.colorbar(im) fig.tight_layout() plt.show() start = time.time() x2 = wavelet.transform_inverse(y) end = time.time() print(end - start) fig = plt.figure() ax = fig.add_subplot(211) ax.plot(np.arange(x.shape[-1]) / fs, x) ax.set_title('original') ax = fig.add_subplot(212) ax.plot(np.arange(x.shape[-1]) / fs, x2) ax.set_title('recovered') fig.tight_layout() fig = plt.figure() ax = fig.add_subplot(111) ax.plot(x[fs // 2:fs // 2 + 500], label='original') ax.plot(x2[fs // 2:fs // 2 + 500], label='recovered') ax.legend(loc='upper right') plt.show()連続ウェーブレット変換によるスペクトログラムはこんな感じです。

信号の振幅はどの周波数でも1ですが、スペクトログラムでは同じ値になっていませんね。ただし、これはバグではなく連続ウェーブレット変換の仕様のようです。

スペクトログラムの周波数毎のスケールを揃える方法は別記事に書こうと思います。逆変換の結果も見ておきましょう。

振幅が揃っているので(4.2)式の係数は合ってそう。0.5秒から500ポイント描画したものが以下です。

ピッタリ重なっていますね。大丈夫そうです。まとめ

連続ウェーブレット変換を離散化した式を導出し、それをPython3で実装しました。

逆変換の近似の妥当性について詳しい検証が必要ですが、テストコードではうまく復元できていることが確認できました。現在では、英語ができれば専門的な内容であってもネット上で情報を見つけることができます。しかし、そのようなページの中でも信憑性は微妙なページが少なからずあるという良い教訓になりました。

お盆休みを消し飛ばさないためにも、キチンとした文献を読んで学ぶことが大事ですね。実装したコード全文はGitHubに上げています。

参考文献

- I. Daubechies著, 山田道夫, 佐々木文夫訳, 「ウェーブレット10講」, 丸善出版, 2003年.

- C. Torrence and G. P. Compo, "A Practical Guide to Wavelet Analysis", Bulletin of the American Meteorological Society, Vol.79, No.1, p.61-78, 1998.

今回の離散化は離散ウェーブレット変換と異なります。今回はあくまで連続ウェーブレット変換を使ってみようってことを目的としています。 ↩

英語版wikipediaのContinuous wavelet transformのページでは$2\pi$がありません。また、Matlab開発元のMathWorksの逆連続ウェーブレット変換のページでも$2\pi$がありません。 ↩

$a = \frac{\lambda}{l\Delta f}$とおけば、$\frac{da}{dl} = -\frac{\lambda}{l^{2} \Delta f} = -\frac{a}{l}$となるので、これを適用してあげれば導出できます。 ↩

$\frac{d}{d\omega}\hat{\psi}(\omega) = 0$とおいて計算していけば求められます。 ↩

厳密には$N$が2のべき乗の時に成り立ち、それ以外ではもう少し遅くなります。 ↩

- 投稿日:2019-08-19T22:17:40+09:00

鍵盤画像からの輪郭検出の練習PGM

鍵盤画像からの輪郭検出の練習PGM

openCVを用いた輪郭検出の練習PGMです

今回作成したPGMのgithubURL: https://github.com/NanjoMiyako/RinkakuKensyutuTest1

処理手順

1. makeOriginPicture.pyで元画像から鍵盤領域だけを抜き出した

画像を取得

2.RinkakuKensyutu.pyから1で作成した画像から輪郭領域を取得

各輪郭の矩形範囲を描画参考URL

Pythonを用いた画像処理(openCV,skimage) - Qiita

Python, OpenCVで画像ファイルの読み込み、保存(imread, imwrite) | note.nkmk.me

[OpenCV][Python3]検出した輪郭を描画し、輪郭線を近似して滑らかにする - Qiita

- 投稿日:2019-08-19T22:13:04+09:00

ijsonでjsonを少しずつ読み込む

はじめに

大容量のjsonをpythonのjsonライブラリで解析しようとしてメモリがすごく食われてメモリエラーになる事態になってしまいました。

そこでストリーム形式のパーサーを探してijsonを見つけましたが、資料が少ないためまとめます。

※簡単に使えるのでそもそも資料が不要かもしれません。環境

- python:3.6.5

- ijson:2.4

インストール

インストールは普通にpipでインストールします。

>pip install ijson Collecting ijson ... Successfully installed ijson-2.4使用方法

jsonの値の取得

ijsonのitems関数にjsonのファイルオブジェクトと取得したいキーを与えるとジェネレータが返却されます。

そのジェネレータからnextやループでjsonの値をとることができます。import ijson with open(jsonファイル, "r") as file_obj: ijson_generator = ijson.items(file_obj, "キー1.キー2") key2_value = next(ijson_generator)jsonのリストの取得

ほとんど値の取得と同様です。

リストの場合は取得したいキーの後にitemを追加してあげる必要があります。

返却されたジェネレータからループでjsonの値をとることができます。import ijson with open(jsonファイル, "r") as file_obj: ijson_generator = ijson.items(file_obj, "キー1.キー2.item") for value in ijson_generator: valuejson全体の解析

例えば、キーが可変のjsonを受け取る際などにキーを指定せずにjsonの解析をすることもできます。

prefixにはキーがeventには型、valueには値が格納されます。

以下の点が特殊なので気を付けてください。

- jsonのルート階層の情報を解析したときのprefixは空

- dictの始まりのeventはstart_map, valueはNone

- dictの終わりのeventはend_map, valueはNone

- dictのキーのeventはmap_key

- listの始まりのeventはstart_array, valueはNone

- listの終わりのeventはend_array, valueはNone

- listの要素のキーはキー.item

import ijson with open(jsonファイル, "r") as file_obj: pet_parse = ijson.parse(file_obj) for prefix, event, value in pet_parse: print("prefix:{}, event:{}, value:{}".format(prefix, event, value))文字列の解析

今まではjsonファイルを開いて解析していましたが、WEBアプリケーションなどでは送信された文字列を解析したい場面があると思います。

そのような場合でも、ストリーム形式にしてあげることでijsonで解析ができます。import ijson import io json_str = '{"pets": {"type": "dog","age": 5,"like": ["walking","eating","hamster"]},"dog": "bow"}' pet_parser = ijson.parse(io.StringIO(json_str)) for prefix, event, value in pet_parser: print("prefix:{}, event:{}, value:{}".format(prefix, event, value))小ネタ

jsonの階層を無視してすべてのkeyを取りたい場合は、eventを利用して楽にできる

イコールの値を変えれば階層を無視して同じ型の情報を楽に集められるwith open(ファイル名, "r") as file: pet_parser = ijson.parse(file) map_keys = [value for pet_parse, event, value in pet_parser if event == 'map_key'] print('map_keys:{}'.format(map_keys))実例

使用するjson

animal.json{ "pets": { "type": "dog", "age": 5, "like": [ "walking", "eating", "hamster" ] }, "dog": "bow" }使用するpython

pyMod.pyimport ijson import io print('------ get value ---------') with open('animal.json', 'r') as file: pet_type = ijson.items(file, 'pets.type') print(next(pet_type)) print('------ get list ---------') with open('animal.json', 'r') as file: pet_like = ijson.items(file, 'pets.like.item') for value in pet_like: print(value) print('------ get all ---------') with open('animal.json', 'r') as file: pet_parse = ijson.parse(file) for prefix, event, value in pet_parse: print('prefix:{}, event:{}, value:{}'.format(prefix, event, value)) print('------ get all str ---------') json_str = '{"pets": {"type": "dog","age": 5,"like": ["walking","eating","hamster"]},"dog": "bow"}' pet_parser = ijson.parse(io.StringIO(json_str)) for prefix, event, value in pet_parser: print('prefix:{}, event:{}, value:{}'.format(prefix, event, value)) print('------ get keys ---------') with open('animal.json', 'r') as file: pet_parser = ijson.parse(file) map_keys = [value for pet_parse, event, value in pet_parser if event == 'map_key'] print('map_keys:{}'.format(map_keys))結果

------ get value --------- dog ------ get list --------- walking eating hamster ------ get all --------- prefix:, event:start_map, value:None prefix:, event:map_key, value:pets prefix:pets, event:start_map, value:None prefix:pets, event:map_key, value:type prefix:pets.type, event:string, value:dog prefix:pets, event:map_key, value:age prefix:pets.age, event:number, value:5 prefix:pets, event:map_key, value:like prefix:pets.like, event:start_array, value:None prefix:pets.like.item, event:string, value:walking prefix:pets.like.item, event:string, value:eating prefix:pets.like.item, event:string, value:hamster prefix:pets.like, event:end_array, value:None prefix:pets, event:end_map, value:None prefix:, event:map_key, value:dog prefix:dog, event:string, value:bow prefix:, event:end_map, value:None ------ get all str --------- prefix:, event:start_map, value:None prefix:, event:map_key, value:pets prefix:pets, event:start_map, value:None prefix:pets, event:map_key, value:type prefix:pets.type, event:string, value:dog prefix:pets, event:map_key, value:age prefix:pets.age, event:number, value:5 prefix:pets, event:map_key, value:like prefix:pets.like, event:start_array, value:None prefix:pets.like.item, event:string, value:walking prefix:pets.like.item, event:string, value:eating prefix:pets.like.item, event:string, value:hamster prefix:pets.like, event:end_array, value:None prefix:pets, event:end_map, value:None prefix:, event:map_key, value:dog prefix:dog, event:string, value:bow prefix:, event:end_map, value:None ------ get keys --------- map_keys:['pets', 'type', 'age', 'like', 'dog']おわりに

jsonをストリーム形式で解析する方法を記載しましたが、キーの位置次第で一括で変換するよりも遅くなる場合があると思います。

そもそも論を言うとそこまで大きなjsonにするべきではない。少なくともdictの中にdictやlistを持たせるような複雑な構造にしてはいけないと思います。

慣れの問題もあるかもしれませんが、csvは情報が足りないと感じ、xmlは情報が過剰な気がしてjsonが程よい気がして、なんでもかんでもjsonにしたい気持ちもすごくわかります。

ならばせめてjsonの構造を簡単にして大容量にならないように工夫するのが一番かなと思っています。

- 投稿日:2019-08-19T22:12:08+09:00

Serverless Frameworkでboto3をモックしてテストする

Serverless FrameworkやSAMなどのサーバーレスアプリを開発するためのフレームワークでは、Lambda関数をテストする手法として、LocalStackやDynamoDB localを用いてローカルでテストを実行することができます。しかし今回は、それよりも単体テストに近い様なテストをPythonのライブラリであるmotoを用いてboto3をモックし、lambdaのテストを簡単に行う方法を書いていこうと思います。

環境

- Python 3.6

- Serverless Framework 1.39.0

- boto3 1.9.208

- moto 1.3.13

使用例

lambda関数

ここではDynamoDBからアイテムを取得して、レスポンスする簡単なlambdaを作成しました。

import json import boto3 from decimal_encoder import DecimalEncoder def get_article(event, context): dynamodb = boto3.resource('dynamodb') table = dynamodb.Table('article') article_id = event['pathParameters']['article_id'] res = table.get_item( Key={ "article_id": article_id } ) article = res.get('Item') response = { "statusCode": 200, "body": json.dumps(article, cls=DecimalEncoder) } return responseテストコード

@mock_dynamodb2を書くことによってその関数内のboto3のDynamoDB関係のライブラリをモックしてくれる様になります。GETメソッドをテストするときなどはあらかじめテーブルにデータが入っていてほしい場合があるかと思います。そういう時も、テストコード内で通常と同様にput_itemをすることでデータを入れることができます。import unittest import boto3 from moto import mock_dynamodb2 from handler import get_article from test.utility import init_dynamodb class TestEvent(unittest.TestCase): @mock_dynamodb2 def test_get_article(self): # articleテーブルを作成 init_dynamodb() # テストのためのarticleを一つ追加 dynamodb = boto3.resource('dynamodb') table = dynamodb.Table('article') item = { 'article_id': 1, 'title': 'test_title', 'body': 'test_article_body', } table.put_item(Item=item) # lambdaに渡すパラメーターを設定 event = { 'pathParameters': { 'article_id': 1 } } # 関数を実行 response = get_article(event, []) print(response) # {'statusCode': 200, 'body': '{"article_id": 1, "title": "test_title", "body": "test_article_body"}'} # テスト self.assertEqual(200, response['statusCode'])ちなみに、init_dynamodb()の内容は以下の様になっていて、articleというテーブルを事前に作成しています。この様な形で必要なテーブルを全て事前に作成することで、簡潔で綺麗なテストコードにすることができます。

import boto3 from moto import mock_dynamodb2 @mock_dynamodb2 def init_dynamodb(): dynamodb = boto3.resource('dynamodb') dynamodb.create_table(**{ 'TableName': 'article', 'AttributeDefinitions': [ { 'AttributeName': 'article_id', 'AttributeType': 'N' } ], 'KeySchema': [ { 'AttributeName': 'article_id', 'KeyType': 'HASH' } ], 'ProvisionedThroughput': { 'ReadCapacityUnits': 1, 'WriteCapacityUnits': 1 } })まとめ

今回はDynamoDBの機能だけしか使いませんでしたがmotoでは、同様にして様々なAWSのサービスをモック化することができます。対応しているサービスはmotoのgithubに詳しく書いてあるので興味のある人は読んでみてください。サーバーレスアプリのテスト手法の一つとして非常に便利そうなので、ぜひ活用してみてください。

- 投稿日:2019-08-19T22:11:03+09:00

Pythonのproxy回避

はじめに

会社内でmnist.load_data()などで外部のdatasetを利用しようとした場合に、社内のproxyに阻まれてしまいました。さらに、proxyに認証が必要な場合の記事が見つからなかったので、情報共有のために記事にしました。

回避方法

import urllib proxy_support = urllib.request.ProxyHandler({'https':'http:userName:password@proxy_adress:portNumber'}) opener = urllib.request.build_opener(proxy_support) urllib.request.install_opener(opener)こちらの2行目のuserNameとpasswordに自分の社内の認証IDとPASSを記入してください。

そして、@の後に自分の会社のプロキシサーバのアドレスとポート番号を各々当てはめてくれれば通過できると思います。

- 投稿日:2019-08-19T21:50:01+09:00

初心者がdjangoで作ったアプリをサーバーへデプロイしてみたいので環境整えるところまで

環境と背景

MacOS Mojave / CentOS7 / VirtualBox / iterm2

学習の中でせっかくwebアプリを作ったのでデプロイしたい。

VPSなど自分で管理するサーバーへデプロイする方法をMemo

セキュリティ関連の知識は別で蓄える必要があるようなので、ここではデプロイまでのプロセスとして。

必要物を集める

VirtualBox

https://www.virtualbox.org/にアクセスしてダウンロード。間違えようがないくらいデカいボタンがあるけど一応スクショ。

急に文字文字し出すので、「VirtualBox 6.0.10 platform packages」の欄を見て該当の利用OSを選択。Macなので「OS X hosts」。

完了したら、そのままインストールでOKかと。

ちなみにVirtualBoxを一言で解説すると

PCに仮想環境を構築して、他のOSをインストールすることができる仮想化ソフトのこと。(仮想の)パソコンをもう一個持つようなイメージかな。

CentOS

https://www.centos.org/にアクセスしてダウンロード。こちらも大きなボタンがあるので問題なし。

DVD ISOだとフルパッケージだけどまぁ重い。。。ひとまずMinimalで様子をみる。

Oh!激しい文字文字感が。。。

上部のブロックは住んでる地域に近いところで提供してくれているものらしい。ということは下部は遠いってこと。

たしかに、上部のブロックのアドレスを見てみると tsukuba とか yamagata って書いてある。

こういう分散して同じものなのに、あっちこっちからダウンロードできるようになっているものを「ミラーサイト」と呼んでいて、一箇所に集中することで高負荷になってしまうことを避けるための仕組みになっている。

多少、免疫がつくまでは違和感しかなかった。

その他

vagrantという素晴らしいツールがあるそうだが一旦ここでは使わない方向で。

VirtualBoxにCentOSをインストール準備

VirtualBoxを立ち上げて「新規」のボタンを押すと「名前」の入力を求められるので「CentOS 7」などと入力。下のプルダウンも勝手に変わってくれた。

基本は次への連打で良いと思うけど流石に最後の8GBは悩んだが一応そのままで。

終わったら「設定」アイコンを押して、ストレージを選択。

光学ドライブと書いてある場所の右側、おそらくCDと思われる青いアイコンを押して、ファイルを選択を押す。

先ほどダウンロードしておいたCentOS(拡張子ISO)を選んで「OK」

次にネットワークのアイコンを選んで

「アダプター2」のネットワークアダプターを有効にして、「ブリッジアダプター」を選んで「OK」。

起動してOSインストール

起動のアイコンを押して起動。

「Install CentOS 7」 を選択。

この時、ポップアップが出てくるので「capture」を選択しておく。

これで「PC本体画面」と「VirtualBox内の画面」のマウスがそれぞれ選択できるようになる。

左側の⌘キーでどちらのマウスを動かすか、変更が可能。

まずは言語選択で日本語を選択。

ここで「インストール先」を選択して、特に設定は変更しなくて良いので、完了ボタンを押すと、さっきまであった「!マーク」が消える。

「ソフトウェアの選択」を選ぶと、上記のOSインストール時に「Minimal」なら選択できないが、「DVD」を選んだ場合には「開発ツール」というソフトもチェックできるようになる。

ちなみに。

Minimalを選んだ場合にも「開発ツール」はインストール可能。(後ほど)インストールをしている間にROOTパスワードと、ユーザーの作成が可能になるので登録しておく。

インストールが完了すると「再起動ボタン」が出るので再起動する。

インストール後の初期設定

再起動するとユーザー名とパスワードを求められるので、先ほど設定したもの入力して起動。

シャットダウンとかは管理者権限がないとできないので、

$ SUとしてパスワードを入力。コマンドの前の「$」が「#」になる。

「#」になっていればrootユーザーということ。元のユーザーに戻るには

# exit終了するには

# shutdown -h nowしばらくかかってVirtualBoxのTOP画面に戻る。

事前の環境構築

ターミナルからIPアドレスでSSH接続

先ほどシャットダウンしているので、再度、起動アイコンを押して立ち上げる。登録userでログインしておく。

$ ip addrこれで接続されているIPアドレスを確認しておく。

いくつかそれっぽいのが見えるけど、一番下段の方のIPが示しているもの。

ターミナルを立ち上げて

$ ssh user@xxx.xxx.xx.xuserはユーザー名

xxxはIPアドレスを入力。接続後にPythonのバージョンを確認してみると

$ python -Vなんと2系。。。

ここからは

・3系をインストールする準備物

・python3系のインストール

・pipのインストール

・venvのインストール

・venvで環境設定ということで「IUS」というRedHatやCentOSなど向けに新しいRPM(ソフトウェアパッケージ管理ツール)を提供しているリポジトリがあるので追加。

$ suでスーパーユーザーに切り替えて

3系をインストールする準備物# yum install -y https://centos7.iuscommunity.org/ius-release.rpm# yum install epel-releasepython3系のインストール

# yum install python36upipのインストール

# sudo yum install python2-pip更新メッセージが出ていたら最新にしておく。

# pip install --upgrade pipvenvのインストール

# pip install virtualenvおまけ

Cent OS のところで「開発者ツール」を入れたいと思ったら# yum groupinstall "Development Tools"いくつか不足しているらしいのでさらに。

# yum -y install openssl openssl-devel readline-devel zlib-devel curl-devel libyaml-devel flex libxml2-devel zlib-devel libpng-devel libjpeg-devel libXpm-devel freetype freetype-devel

デプロイ前の準備

デプロイするディレクトリを作る。

# mkdir -p /opt/django # cd /opt/django # virtualenv -p python3.6 sns「opt」や「django」は任意の名前。「sns」は任意のプロジェクト名。

ここで作った「sns」ディレクトリに移動すると「bin」ディレクトリもできているので

# source bin/activateでvenv環境に入ることができる。(以前の記事はこちら)

Gitもインストール

(sns)# yum install gitクローン:Gitのリポジトリの内容をそのまま持ってくること

(sns)# git clone https://xxx.xxxxxxは自身のものに合わせて。Bitbucketならリポジトリに入った上部に記載してあるURL。

Djangoもインストールしておく

(sns)# pip install django長くなりそうなので、ひとまずここまで。

- 投稿日:2019-08-19T20:24:25+09:00

2次元のセルラー・オートマトン(ライフゲーム)をPythonで試す

TL;DR

- 2次元環境でのセルラー・オートマトンを復習しつつPythonで動かします。

- 以下のようなアニメーションのものを作ります。

主な参考文献

また、上記書籍のgithubのリポジトリのコードもMITライセンスなので参照・利用させていただきますmm

※本記事では割愛した説明なども山ほどあるので、ALife関係の詳細は書籍をお買い求めください。

前提

以前書いた1次元のセルラー・オートマトンの記事をベースとしています(用語の説明なども含め、重複している箇所の説明は省きます)。

ライフゲームとは

ライフゲーム (Conway's Game of Life[1]) は1970年にイギリスの数学者ジョン・ホートン・コンウェイ (John Horton Conway) が考案した生命の誕生、進化、淘汰などのプロセスを簡易的なモデルで再現したシミュレーションゲームである。単純なルールでその模様の変化を楽しめるため、パズルの要素を持っている。

生物集団においては、過疎でも過密でも個体の生存に適さないという個体群生態学的な側面を背景に持つ。セル・オートマトンのもっともよく知られた例でもある。

ライフゲーム - Wikipediaより。3x3のグリッドで、中央のグリッドが次の時間で0になるのか1になるのかを、周囲のグリッドの現在の条件に応じて決められたルールに応じて変化させる計算となります。

1次元のときは左右の2つのセルに応じて次の時間の中央のセルの状態が決定する、というものでしたが、今度は上下と斜めのセルが増えるので、8個のセルに依存します。

それぞれ1が生きている、0が死んでいると表現され、結果として生まれるアニメーションがまるで生命のように振舞ったりすることから名前にライフと付いています。1次元のときは、例えばウルフラムさんのルール0~ルール255のように、様々なルールが存在しました。

2次元のライフゲームでは、固定で以下のようなルールが存在するようです(それぞれ誕生・生存・過疎・過密と呼ばれます)。ライフゲームのルール

誕生・もしくは再生

中央のセルが死んでいる(0)状態で、且つ周りのセルで生きているセル(1)が3つある場合に、次の時間で中央のセルは誕生(もしくは再生と呼ばれます)します(1になります)。

生存・もしくは均衡状態

中央のセルが生きている(1)状態で、且つ周りに生きている(1)セルが2つもしくは3つある場合は、そのセルはそのまま次の時間も生存(1のまま)します(均衡状態とも呼ばれます)。

過疎・もしくは人口過疎

中央のセルが生きている(1)状態で、且つ周りに生きている(1)セルが1つ以下の場合、次の時間に死にます(0になります)。

過剰・もしくは人口過剰

中央のセルが生きている(1)状態で、且つ周りに生きている(1)セルが3つ以上ある場合、次の時間に死にます(0になります)。

生きている状態が多くても少なくても死んでしまい、死んでいる状態で周りに生きている状態が増えたら生き返り、バランスが良い状態の場合はそのまま生き続けるといった感じです。

人口が多すぎると快適に生活ができなかったり、食料が足りなくて死んでしまい、人口が少なすぎても生活で困ってしまう。何も無い状況から突然生物が生まれたりはせず、親が居てはじめて次の世代が誕生する、といったように現実と照らし合わせると面白いルールですね。

Pythonでの実装

使う環境

- Windows

- Python 3.6.8

- NumPy==1.14.5

- Vispy==0.5.3

- Jupyter notebook

- 前述の書籍のgithubのコード

- ※事前にcloneしてimportできるようにしておきます。可視化でalifebook_lib以下のモジュールを利用します。

初期化処理

まずは必要なモジュールのimportや可視化用のウインドウなど含め初期化処理を進めていきます。

import numpy as np from alifebook_lib.visualizers import MatrixVisualizer visualizer = MatrixVisualizer()縦横でいくつずつセルを設けるかを

WIDTHとHEIGHTという名前で定義します。今回は50個ずつ扱います。WIDTH = 50 HEIGHT = 50続いて行列を初期化します。1次元のセルラー・オートマトンの時と同様、次の時間を扱うために、

stateの他にもnext_stateという名前で行列を用意します。stateの方の行列は、ランダムに0もしくは1の値が設定されるように設定しておきます。

state = np.random.randint(low=0, high=2, size=(HEIGHT, WIDTH)) next_state = np.zeros(shape=(HEIGHT, WIDTH), dtype=np.int8) statearray([[1, 1, 1, ..., 1, 0, 1], [0, 0, 0, ..., 0, 1, 1], [1, 1, 1, ..., 1, 0, 1], ..., [0, 0, 0, ..., 0, 1, 0], [1, 0, 0, ..., 1, 1, 0], [0, 0, 0, ..., 1, 0, 1]])続いて、状態を更新するためのループを実装します。

行列全体に処理をする必要があるので、ネストしたfor文で対応します。while True: for row in range(HEIGHT): for column in range(WIDTH): # ...今回は、更新対象のセル(row, columnの位置のセル)の周囲を含めて、9個のセルの現在の値を参照する必要があります。

それぞれ、以下の図のように東西南北で変数名を設定します。行もしくはカラムのインデックスを加算する箇所(

north_east,east,south_west,south,south_eastの位置)に関しては、インデックスが行列範囲外にならないように、剰余で計算しています(範囲を超えた場合に0に戻るように)。upper_row_idx = row - 1 lower_row_idx = (row + 1) % HEIGHT left_column_idx = column - 1 right_column_idx = (column + 1) % WIDTH north_west = state[upper_row_idx, left_column_idx] north = state[upper_row_idx, column] north_east = state[upper_row_idx, right_column_idx] west = state[row, left_column_idx] center = state[row, column] east = state[row, right_column_idx] south_west = state[lower_row_idx, left_column_idx] south = state[lower_row_idx, column] south_east = state[lower_row_idx, right_column_idx]周りのセルがいくつ生きているか(1なのか)をカウントします。

0か1かの値なので、そのままcenter以外を加算していけば実現できます。neighbor_cell_sum = (north_west + north + north_east, + west + east + south_west + south + south_east)続いて、誕生(もしくは再生)の条件を書きます。中央が生きていて(1)、且つ回りに生きているセルが3つ存在する、という条件になります。

if center == 0 and neighbor_cell_sum == 3: next_state[row, column] = 1生存(もしくは均衡状態)の条件を書きます。中央が生きている(1)で且つ周りに生きているセルが2つもしくは3つの場合はそのまま生きたままになります。

elif center == 1 and neighbor_cell_sum in (2, 3): next_state[row, column] = 1そのほかの過剰や過疎の条件は死ぬように条件を設定しておきます。

else: next_state[row, column] = 0最後に、for文の外で次の時間の状態の行列(

next_state)の値を現在の状態の行列に反映し、可視化のオブジェクトに行列を渡して完成です。state[:] = next_state[:] visualizer.update(1 - state)ループのコードは最終的に以下のようになりました。

while True: for row in range(HEIGHT): for column in range(WIDTH): upper_row_idx = row - 1 lower_row_idx = (row + 1) % HEIGHT left_column_idx = column - 1 right_column_idx = (column + 1) % WIDTH north_west = state[upper_row_idx, left_column_idx] north = state[upper_row_idx, column] north_east = state[upper_row_idx, right_column_idx] west = state[row, left_column_idx] center = state[row, column] east = state[row, right_column_idx] south_west = state[lower_row_idx, left_column_idx] south = state[lower_row_idx, column] south_east = state[lower_row_idx, right_column_idx] neighbor_cell_sum = (north_west + north + north_east + west + east + south_west + south + south_east) if center == 0 and neighbor_cell_sum == 3: next_state[row, column] = 1 elif center == 1 and neighbor_cell_sum in (2, 3): next_state[row, column] = 1 else: next_state[row, column] = 0 state[:] = next_state[:] visualizer.update(1 - state)動かしてみると、以下のようなアニメーションをします。

ランダムな行列(実質ノイズ的な値)から、なんだかセル同士で近寄ったり、その結果消えて無くなったり・・・と、まるで生きているように、顕微鏡で微生物を見ている時みたく、意志を持っているかのような独特な動きになりました。

他のパターンを試す

1次元のセルラー・オートマトンでは各ルールを変えることで生成される模様が変わります。

今回の2次元のライフゲームでは、最初に与える状態の行列を調整することで色々なパターンに切り替わります。サンプルとして本記事では、グライダーとグライダーガンと呼ばれるパターンを動かしてみます。

グライダーパターン

まず、ランダムな初期状態を設定している箇所をコメントアウトします。

# state = np.random.randint(low=0, high=2, size=(HEIGHT, WIDTH))続いて、状態の行列を0で初期化し、グライダーパターンを生成するパターンを行列に与えます(行列の一部だけを更新します)。

pattern = np.array( [[0, 0, 0, 0], [0, 0, 1, 0], [0, 0, 0, 1], [0, 1, 1, 1]]) state[2:2 + pattern.shape[0], 2:2 + pattern.shape[1]] = pattern他のコードはそのままです。この時点で可視化してみると以下のようになります。

visualizer.update(1 - state)左上にのみ、黒い領域が設定されています。この形がなんとなくレトロゲームのグライダーっぽい・・・感じがします。

また、実際に動かしてみると、グライダーのように形をある程度保ったまま移動していくさまを確認できます。興味を惹かれる点として、行列計算のコードはまったく変わっておらず、与える行列の初期値を変えるだけでアニメーションの傾向が変わることです。

グライダー銃(グライダーガン)パターン

グライダーパターンをさらに発展させたものとして、グライダー銃という、周期的にグライダーを生成するようなパターンも存在します。まるでレトロゲームで攻撃のエフェクトを打ち出しているような挙動になります。

コンウェイは「生きたセルの数が無限に増えつづけるパターンはありうるか」という問題に50ドルの懸賞金をかけた。コンウェイ自身は、そのようなパターンとして「周期的だが次々にグライダーを打ち出すもの」や「移動しながら通過した後に破片を残すもの」の存在を予想し、前者を「グライダー銃」、後者を「シュシュポッポ列車」と呼んだ。1970年11月、ビル・ゴスパー(英語版)らは、初めてグライダー銃の具体例を挙げて賞金を獲得した。

ライフゲーム - Wikipediaグライダーパターンと同様に最初に特定の行列の初期値を与えるだけで実現できます。ただし、グライダーパターンと比べて与える行列は大きく複雑です。グライダーパターンが結構発生しやすい(パターンが多い)のに対して、こちらは大分パターンが限られ、しっかり初期値を調整しないと発生してくれないそうです。

以下のように大きな行列の初期値を与えます。

pattern = np.array( [[0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0], [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0], [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 1], [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 1, 0, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 1], [1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 1, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0], [1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 1, 0, 1, 1, 0, 0, 0, 0, 1, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0], [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0], [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0], [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0]])可視化してみると、以下のようになっています。

動かしてみると以下のようなアニメーションになります。

確かに、グライダーパターンが定期的に生成されています。行列の設定だけでこういったアニメーションが生まれるというのはなんだか不思議ですね・・・。

参考文献まとめ

- 投稿日:2019-08-19T18:37:54+09:00

BitDPについて

ある条件を満たす順列の数え上げに関して、n!では間に合わないけど2**nなら間に合いそうという時に使えるテクニックです。

全要素の集合をU、その部分集合をSとしてSに関して条件を満たす並び方の総数をf(S)とします。右(左)端に何を置くかで場合分けを行うと、要素数のひとつ少ないSの部分集合S'の話に帰着するので、帰納的に解くことができます。さらに、dpを効率よく行う方法として、集合をbitで管理するという発想があります。つまり、0110={1, 2}のように対応づけをすると、集合に整数でラベルを貼ることができます。このラベルをn(S)で表すことにすると、S⊇S'ならばn(S)≧n(S')が成立するので、nの小さい方から順に求めていくことで簡単に実装できます。例題:ABC041D

def main(): N, M = map(int, input().split()) edge = [0]*N for i in range(M): x, y = map(int, input().split()) edge[x-1]|=1<<(y-1) dp = [0]*(1<<N) dp[0] = 1 for s in range(1, 1<<N):#集合を添字の小さい順に試す for i in range(N):#全ての要素を考える if ((s>>i)&1) and (not(edge[i]&s)):#i in sかつedge[i]とsが共通部分を持たない dp[s]+=dp[s^(1<<i)] return dp[-1] print(main())(関係ないですがmain()に埋め込むと100msくらい速くなりました。すごい。)

上では色々なbit演算を用いています。いい機会なので、bit演算についてまとめておきます。

|: orのこと。

&: andのこと。

^: xorのこと。実質、繰り上がりのない引き算、足し算

>>: 左シフト。右に0をn個付け加える

<<: 右シフト。右からn桁を削除する

よく使うのは以下のような奴らです。

1<<N: 2**Nのこと

n>>k&1: nのk+1桁目が1かどうか(0-indexedなら右からk番目)

S&T: 集合の積

- 投稿日:2019-08-19T18:35:57+09:00

Python機械学習プログラミングという書籍で間違いを指摘したが認められなかった話

はじめに

[第2版]Python機械学習プログラミングの89ページで間違いと思われる箇所を見つけましたが,認められなかったのでここに書きます.

技術に関する内容ではなく,どちらかといえば日本語に関する内容です.

本文

間違いだと思われる箇所を引用します.(間違いだと思われる箇所は太字にしてあります)

決定木学習の情報利得の文脈でエントロピーに関する話です.

$p(i \mid t)$ は,特定のノード $t$ においてクラス $i$ に属するサンプルの割合を表す.したがって,ノードのサンプルがすべて同じクラスに属している場合,エントロピーは0である.たとえば二値分類においてエントロピーが0になるのは,$p(i=1 \mid t)=1$ または $\mathbf{p(i=0 \mid t)=0}$ の場合である.エントロピーが最大になるのは,各クラスが一様に分布している場合である.二値分類でエントロピーが1になるのは,クラスが$p(i=1 \mid t)=0.5$ および $p(i=0 \mid t)=0.5$で一様に分布している場合である.

間違っていると思った理由を説明します.

二値分類において,エントロピーが0になる場合は2通りあります.

- $p(i=1 \mid t)=1$ および $p(i=0 \mid t)=0$

- $p(i=1 \mid t)=0$ および $p(i=0 \mid t)=1$

二値分類において,エントロピーが1になる場合は1通りあります.

- $p(i=1 \mid t)=0.5$ および $p(i=0 \mid t)=0.5$

以上のことを踏まえると,著者は「 $p(i=1 \mid t)=1$ および $p(i=0 \mid t)=0$ または $p(i=1 \mid t)=0$ および $p(i=0 \mid t)=1$ 」を省略して,「 $p(i=1 \mid t)=1$ または $p(i=1\mid t)=0$ 」と書きたかったのではないかと思いました.

ですので,この文章の,$p(i=0 \mid t)=0$ は $p(i=1 \mid t)=0$ の間違いだとサポートにメールを送ったのですが,認められませんでした.

返信メールの回答部分を抜粋します.

p.89におきまして、式3.6.3下の本文に下記の記述があります。

------------------

したがって、ノードのサンプルがすべて同じクラスに属している場合、エントロピーは 0 である。たとえば二値分類においてエントロピーが 0になるのは、p( i = 1 | t ) = 1 または p( i = 0 | t ) = 0 の場合である。

------------------

「たとえば」からはじまる上の2文目では、「エントロピーが 0 になる」ケースを取り上げたものかと思います。監注35でも「p( i =1 | t)=1 のときは p( i =0 | t)=0 となり」と記載しており、これは上の2文目と同じケースであると考えられます。

また、監注35では、別のケースとして「p( i =1 | t)=0 のときは p( i =0 | t)=1となり」も取り上げています。最初に引用した部分にあるように,回答の引用文の前文でエントロピーが0になるという話をしているのだから,この「たとえば」は明らかに「二値分類」にかかっていると思われます.ですのでこの回答に納得がいかず,再度問い合わせをしたのですが,返信はありませんでした.

最後に

私の理解が間違ってるなどありましたらコメント欄におねがいします.精進いたします.

- 投稿日:2019-08-19T18:18:38+09:00

AC-GANでアニメの顔画像を生成してみた

クラスを条件とした画像生成モデルであるAC-GANを使って、アニメ顔の画像生成してみました。

AC-GANとは

理論的な解説はこちらの記事で書いたので省略。一言でいうと、Dに真偽判定だけではなく、多クラス分類の機能をもたせたものです。

画像はhttps://github.com/gitlimlab/ACGAN-PyTorchより

CIFAR-10でやってみる

手始めとして論文の通りの設定でCIFAR-10を生成してみました。CIFAR-10の訓練データ5万枚を使っているため、1クラスあたりのデータ数は5000枚となります。

サンプリング

クラスラベルも潜在空間の変数も乱数から出力したものです。そこそこ綺麗に出ているのがわかります。潜在空間の補間

AC-GANの論文によると、GANが上手くいっているかどうかを確認する一つの方法として、「潜在空間の補間を行うこと」とありました。これを実行してみます。

行方向でクラスラベルを固定し(0、1、2……)て任意の2つの画像を乱数で生成し、その2つの画像に対応する潜在空間を線形に補間し、対応する画像を生成します(列方向)。出力画像がきれいかどうかはさておいて、このようにクラス単位で滑らかな補間ができれば上手くいっているということになります。

コード

https://gist.github.com/koshian2/d044981c732df855ed25ee4a7372a53e

AnimeFace Character Dataset(全種+論文と同じ)

こちらのAnimeFace Character Datasetを使い、論文と同じ設定で生成してみます。ただし、AnimeFace Character Datasetは176クラスで14490枚の画像があるため、1クラス平均82.3枚とCIFAR-10よりはかなり少ないデータセットになります。

サンプリング

ちょっと出力画像が粗い? ただしこれはネットワーク構造を見直すことで改善します(後述)。潜在空間の補間

潜在空間の補間は上手く言っているように見えますが、実はクラス単位で同一の画像しか生成していないのではないかということに気づきます。これは論文にかかれていたことなのですが、論文のImageNetによる実験では、大量のクラスを同一のネットワーク(AC-GAN)で訓練すると、出力画像の多様性が落ちてしまうという現象が確認されたそうです。ImageNetは1000個のクラスからなりますが、論文では10個のクラスを1つのネットワークとして訓練していました。これも後で試してみます。

コード

https://gist.github.com/koshian2/c067149d97de37a9917237e7c469da51

AnimeFace Character Dataset(全種+ResNetベース)

先程の全種のケースを、ネットワーク構造を変更して実験してみます。

変更点

- GのネットワークをResNetベースに変更する(詳細はコード参照)

- アップサンプリングのレイヤーをConvTransposeからPixelShufflerに変更する

- 損失関数をHinge関数に変更(GauGANの実装を参考にしました)

サンプリング

ネットワークをResNetベースにしたら明らかに綺麗になりました。ただし、多様性の面からは疑問があります(同じ画像を出力しているだけではないか)。

潜在空間の補間

このケースでは、潜在空間の補間がうまくいきませんでした。クラスのラベル(行方向)が効いていなく、それ以外のノイズ(横方向)で説明できてしまいます。データが少なすぎたのか、もしかしたら実装のどこかが良くなかったのかもしれません。

コード

https://gist.github.com/koshian2/9be6d617ba26452a51a9fc2e34477e14

AnimeFace Character Dataset(10種+論文と同じ)

オリジナルの設定に戻し、訓練するクラス数を10に減らします。具体的にはデータの多いクラス上位10個1を採用しました。

サンプリング

全種のクラスと比べて画質が若干良くなりました。論文に書いてあるとおり、AC-GANでは一度に訓練するクラス数が多すぎるのはよくないです。潜在空間の補間

潜在空間の補間は少なくともクラス別の変数はうまく効いているというのがわかります。そこそこ形になっているのが5行目で、潜在空間の乱数によって背景のスタイルをコントロールできているのがわかります。コード

https://gist.github.com/koshian2/7c75e449bf86ba0262a933fed42c7dca

AnimeFace Character Dataset(10種+ResNetベース)

最後にResNetベースで、クラス数10の場合を試してみました。

サンプリング

一部目の位置が怖い感じになっていますが、ぱっと見綺麗に言っているように見えます。ただ多様性の面が厳しそうですね。潜在空間の補間

10種の場合よりかは、クラスの変数が効いているように見えます。しかし、キャラごとの違いが潜在空間の乱数で決まってしまい、class coditionalな生成は上手く行かなかったです。やはり1クラスあたりのデータ数が問題なのかもしれません。コード

https://gist.github.com/koshian2/024e2c247a94c050165942e96a886d27

感想/まとめ

- CIFAR-10(1クラス5000)やImageNet(1クラス1300)のように、1クラスあたりのデータ数が多ければ、AC-GANでもかなりいい感じに生成できそう。AC-GAN自体は若干古い(2016年)モデルなので、最新形を使えばまだ伸びしろはある。

- AnimeFace Character Datasetでは1クラスあたりのデータ数が平均82.3枚で、画像そのものを綺麗に生成することはできたが、生成画像の多様性が課題。データ数が多いほど有利になるのはGANでも変わらない。

- そもそもクラス別にアノテーションされたアニメ絵の画像で、クラス数あたりそこそこの枚数があるデータセットというのを聞いたことがない(存在しない?)

- ResNetが生成画像の高画質化に非常に効いているので、WGANのようにGANの安定性を損失関数でカバーし、ネットワークやデータによる成功可否の依存性を打ち消せれば、GANはかなり有望だと思われる

木之本桜(カードキャプターさくら)、ララ・サタリン・デビルーク(ToLOVEる)、月村真由(ご愁傷さま二ノ宮くん)、向坂環(ToHeart2)、西連寺春菜(ToLOVEる)、天海春香(アイドルマスター)、宮村みやこ(ef)、めろんちゃん(メロンブックス)、スバル・ナカジマ(魔法少女リリカルなのはStrikerS)、日奈森あむ(しゅごキャラ!) ↩

- 投稿日:2019-08-19T18:03:57+09:00

与えられた重みに従ってランダムに値を返す「Weighted Random Selection」をGoで実装する!

Goで 「Weighted Random Selection」 をしたくなる時があります。しかし、Goでは Pythonの

numpyのように便利な関数が提供されていないので自分で作るしかありません。今回は Go で 「Weighted Random Selection」 の実装方法を紹介します。Weighted Random Selection とは

とある重み(確率分布)を元に要素をランダムに選択するやつです。numpyで言うと

numpy.random.choiceに当たります。下記は第一引数 5([0,1,2,3,4]) から3つを確率分布pでランダムに選択する関数です。>>> np.random.choice(5, 3, p=[0.1, 0, 0.3, 0.6, 0]) array([3, 3, 0])ランダムな選択に重複を許可しない場合は引数に

replace=Falseを指定します。>>> np.random.choice(5, 3, replace=False, p=[0.1, 0, 0.3, 0.6, 0]) array([2, 3, 0])今回はGoでこの処理を行う際の実装を紹介します。

Go による Weighted Random Selection

今回は最もシンプルな Linear Scan アルゴリズムで実装します。やることは[0~weightの合計値]の間でランダムに基準となる値を選び、基準からweightを順に引いていき、0以下になったらそれが選択されます。

早速実装していきます。下記はvの中からwの確率分布に従って1つだけ値を取得する関数です。

// 0 ~ max までの範囲でランダムに値を返す var randGenerator = func(max float64) float64 { rand.Seed(time.Now().UnixNano()) r := rand.Float64() * max return r } func weightedChoiceOne(v int, w []float64) float64 { // v を slice に変換 // ex) 5 -> [0, 1, 2, 3, 4] vs := make([]int, 0, v) for i := 0; i < v; i++ { vs = append(vs, i) } // weightの合計値を計算 var sum float64 for _, v := range w { sum += v } // weightの合計から基準値をランダムに選ぶ r := randGenerator(sum) // weightを基準値から順に引いていき、0以下になったらそれを選ぶ for j, v := range vs { r -= w[j] if r < 0 { return v } } // should return error... return 0 }最後の

return 0はたまたま1つも選ばれなかった(基準がweightの合計と丁度一致した時など)場合に到達します。確率的にほとんどありませんが、ここはこの関数を使う状況によってエラーハンドリングや空で返すなどの対策が考えられます。上記のコードを少し変更すれば選ぶ数の指定 & 重複排除も実装できます。ポイントは選ばれた物をスライスから排除しておくことです。

func weightedChoice(v, size int, w []float64) ([]float64, error) { // v を slice に変換 // ex) 5 -> [0, 1, 2, 3, 4] vs := make([]int, 0, v) for i := 0; i < v; i++ { vs = append(vs, i) } // weightの合計値を計算 var sum float64 for _, v := range w { sum += v } result := make([]float64, 0, size) for i := 0; i < size; i++ { r := randGenerator(sum) for j, v := range vs { r -= w[j] if r < 0 { result = append(result, float64(v)) // weightの合計値から選ばれたアイテムのweightを引く sum -= w[j] // 選択されたアイテムと重みを排除 w = append(w[:j], w[j+1:]...) vs = append(vs[:j], vs[j+1:]...) break } } } return result, nil }選択されたアイテムと重みの削除のコードが少し特殊に見えますが、下記の公式Wikiを参考に実装しています。

https://github.com/golang/go/wiki/SliceTricks#deleteこれを使えば与えられたweightにしtがってランダムに値を返します。

func main() { r1 := weightedChoiceOne(5, []float64{0.1, 0.1, 0.2, 0.9, 0.1}) r2, _ := weightedChoice(5, 4, []float64{0.1, 0.9, 0.2, 0.3, 0.1}) fmt.Println(r1) // 3 fmt.Println(r2) // [1 3 2 0] }これで Weighted Random Selection が実装できました! 今回は最もシンプルな Linear Scan での実装を紹介しましたが、そのほかのアルゴリズムはこのサイトが勉強になります。https://blog.bruce-hill.com/a-faster-weighted-random-choice

コードは Go Playground にあげておきます。

https://play.golang.org/p/-vqQEvwCi44

- 投稿日:2019-08-19T17:59:05+09:00

Macにpyenv + AnacondaでPython環境作成の備忘録

はじめに

- Pythonをお勉強するため、Mac上にPython開発環境を整えてみたので、自分用の備忘録としてまとめました。

- ゴールは、Anaconda(Python3系)をインストールしてJupyter Notebookで作業できるまでとしました。

動作環境

- macOS Mojave 10.14.6

1. Homebrewのインストール

1-1. Homebrewとは

wikipedia

Mac OS X オペレーティングシステム上でソフトウェアの導入を単純化するパッケージ管理システムのひとつ。

- パッケージをインストール、アンインストールできる管理システムのこと。

1-2. インストール方法

- Homebrewにアクセス。

- スクリプトをコピーし、ターミナルで実行。

- インストール確認。

bash# スクリプト実行 $ /usr/bin/ruby -e "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install)" # ログ ==> This script will install: /usr/local/bin/brew /usr/local/share/doc/homebrew ︙ ==> The Xcode Command Line Tools will be installed. # Xcode Command Line Toolsをインストールする場合は、RETURNを押下。 Press RETURN to continue or any other key to abort ==> /usr/bin/sudo /bin/chmod u+rwx /usr/local/bin # ログイン時のPasswordを入力 Password: ==> /usr/bin/sudo /bin/chmod g+rwx /usr/local/bin ︙ Already up-to-date. ==> Installation successful! # インストール確認 $ brew --version # ログ Homebrew 2.1.92. pyenvのインストール

2-1. pyenvとは

- Pythonのバージョンを管理できるコマンドラインツールのこと。

2-2. インストール方法

Homebrewでpyenvをインストール。- インストール確認。

pyenvにPathを通す。- 設定(Path)の適用。

bash# pyenvをインストール $ brew install pyenv # インストール確認 $ pyenv --version # ログ pyenv 1.2.13 # pyenvにPathを通す $ echo 'export PYENV_ROOT="$HOME/.pyenv"' >> ~/.bash_profile $ echo 'export PATH="$PYENV_ROOT/bin:$PATH"' >> ~/.bash_profile $ echo 'eval "$(pyenv init -)"' >> ~/.bash_profile # 設定の適用 $ source .bash_profile3. Anacondaのインストール

3-1. Anacondaとは

wikipedia

データサイエンスおよび機械学習関連アプリケーション(大規模データ処理、予測分析(英語版)、科学計算)のためのPythonおよびRプログラミング言語のフリーでオープンソースのディストリビューションであり、パッケージ管理および展開の単純化を目指したものである。

- 「Python」 + 「各種ライブラリ」をまとめて含んだパッケージのこと。

3-2. インストール方法

pyenvでインストール可能なAnacondaを検索。- Anacondaをインストール。

bash# インストール可能なAnacondaを検索 $ pyenv install -l | grep anaconda # ログ anaconda-1.4.0 ︙ anaconda2-5.0.0 ︙ anaconda3-5.3.1 # インストール $ pyenv install anaconda3-5.3.14. Anacondaで仮想環境を作成

作成方法

condaで仮想環境を作成。- 作成した仮想環境を作業ディレクトリで有効化(

pyenv local)。activateで仮想環境を起動。- Jupyter Notebookを起動。起動できればゴール。

bash# Anacondaをglobalに切り替え $ pyenv global anaconda3-5.3.1 # 仮想環境を作成 $ conda create --name anaconda_py3.6 python=3.6 anaconda # 作成した仮想環境を作業用ディレクトリで有効化 $ mkdir Workspace $ cd Workspace $ pyenv local anaconda3-5.3.1/envs/anaconda_py3.6 # globalをsystemへ戻す $ pyenv global system # 作成した仮想環境をActivateで起動(フルパスで指定) $ source $PYENV_ROOT/versions/anaconda3-5.3.1/bin/activate anaconda_py3.6 # 作業ディレクトリでjupyter Notebookを起動 $ cd Workspace $ jupyter notebook5. Jupyter Notebookで仮想環境を指定する

- 作成したAnacondaの仮想環境をJupyter Notebook上で指定できるようにする。

5-1. 設定方法

- Anacondaのデフォルト環境:base(root)でJupyter Notebookに対するパッケージ追加とその設定を行う。

bash# パッケージの追加 $ pip install environment_kernels # 設定ファイルの生成 $ jupyter notebook --generate-config # 設定を追加 $ echo "c.NotebookApp.kernel_spec_manager_class = 'environment_kernels.EnvironmentKernelSpecManager'" >> ~/.jupyter/jupyter_notebook_config.py $ echo "c.EnvironmentKernelSpecManager.conda_env_dirs=['/Users/toyoizumi/.pyenv/versions/anaconda3-5.3.1/envs/']" >> ~/.jupyter/jupyter_notebook_config.py6. 仮想環境の切り替え方法

- 環境の切り替えは、

activateとpyenv localを併用。bash# Activateで指定環境を起動できる(フルパスで指定) $ source $PYENV_ROOT/versions/anaconda3-5.3.1/bin/activate anaconda_py3.6 # 作業ディレクトリごとに仮想環境を指定できる $ mkdir Workesapce $ cd Workuspace $ pyenv local anaconda3-5.3.1/envs/anaconda_py3.6 # Deactivateで環境を解除できる(フルパスで指定) $ source $PYENV_ROOT/versions/anaconda3-5.3.1/bin/deactivate anaconda_py3.7

activateをフルパスで実行するのは煩わしいので、aliasを設定。bash# .bashrcにaliasを追加 $ echo 'alias activate="source $PYENV_ROOT/versions/anaconda3-5.3.1/bin/activate"' >> ~/.bashrc # 設定の適用 $ source ~/.bashrc # 「activate + 仮想環境名」で指定環境を起動出来る $ activate anaconda_py3.6 # 指定環境でJupyter Notebookを起動出来る $ jupyter notebook

- 投稿日:2019-08-19T17:12:02+09:00

python のコーディングにVisual studio 2019 Community Bottole Template

pythonのコーディングに何を使っていますか。Pycarmもいいけど私は、Visual Studio 2017/2019を使っています。

多彩なツールを自由に組み込むことができます。今回は、素早くRasipberry pi 用にweb serverを立ち上げるためにBoostrap4用bottle Templateをご紹介します。Visual studio に添付されているbottleWebテンプレートをベースに作成しました。

Boostrap4にこだわる理由は、スマートフォン用のUIを簡単に作ることができるからです。

例えば、スマートフォンやタブレット用ボタンスイッチAPPを作るには、

routes.py に追加

routes.py@route('/btn') @view('btn') def btn(): return dict( year=datetime.now().year )btn.tpl テンプレートをを作成% rebase('layout.tpl', title='Home Page', year=year) <main role="main"> <div class="container" style="margin:2em;"> % ix=0 % for j in range(4): <div class="row" style="margin:1em;"> % for i in range(4): <div class="col-md-3"> <button data-i={{ix}} class='btn btn-outline-primary btn-lg btn-block'style='height:100px;'><h1>ボタン{{ix}}</h1></button> %ix=ix+1 </div> % end </div> % end <hr> </div> <!-- /container --> </main> <script> $(function(){ $('#flipclock').FlipClock({clockFace: 'TwentyFourHourClock'}); var on=0; $('.btn').click(function(){ if($(this).hasClass('btn-primary')) { //off $(this).removeClass("btn-primary"); $(this).addClass("btn-outline-primary"); on=0; } else { //on $(this).removeClass("btn-outline-primary"); $(this).addClass("btn-primary"); on=1; } $.ajax({ type: "POST", url: "/relay", data: { "id":$(this).attr('data-i'), "cmd": on, "relay":$(this).attr('data-i')}, success: function(data){} }); }); }); </script>ファイルをgithubに置いておきます。

https://github.com/yutakahirata/Bottle4Template/tree/master/bottle4/bottle4

tree.txtbottle4 │ app.py │ bottle4.pyproj │ bottle4.pyproj.user │ requirements.txt │ routes.py ├─static │ ├─content #その他必要なスタイルシートを追加します。 │ │ bootstrap-grid.css │ │ bootstrap-grid.css.map │ │ bootstrap-grid.min.css │ │ bootstrap-grid.min.css.map │ │ bootstrap-reboot.css │ │ bootstrap-reboot.css.map │ │ bootstrap-reboot.min.css │ │ bootstrap-reboot.min.css.map │ │ bootstrap.css │ │ bootstrap.css.map │ │ bootstrap.min.css │ │ bootstrap.min.css.map │ │ jumbotron.css │ │ site.css │ │ │ ├─fonts #boostrap4では、不必要 │ │ glyphicons-halflings-regular.eot │ │ glyphicons-halflings-regular.svg │ │ glyphicons-halflings-regular.ttf │ │ glyphicons-halflings-regular.woff │ │ │ └─scripts その他のスクリプト(java scriptをここに配置) │ bootstrap.bundle.js │ bootstrap.bundle.js.map │ bootstrap.bundle.min.js │ bootstrap.bundle.min.js.map │ bootstrap.js │ bootstrap.js.map │ bootstrap.min.js │ bootstrap.min.js.map │ jquery-1.10.2.intellisense.js │ jquery-1.10.2.js │ jquery-1.10.2.min.js │ jquery-1.10.2.min.map │ jquery.validate-vsdoc.js │ jquery.validate.js │ jquery.validate.min.js │ jquery.validate.unobtrusive.js │ jquery.validate.unobtrusive.min.js │ modernizr-2.6.2.js │ respond.js │ respond.min.js │ _references.js │ ├─views │ about.tpl │ contact.tpl │ index.tpl │ layout.tpl<<使い方>>

gitからチェックアウトします。

https://github.com/yutakahirata/Bottle4Template.gitbottle4を選択します。

ソリューションを開きます。bottle4.sln

プロジェクト->テンプレートのエクスポートを行います。

新しいプロジェクトを作成します。検索エリアにbottle4と入力するとテンプレートが現れます。

Visual studio 2019 communityを用いサクサクプログラムが書けます。

「いいね!」してね!

- 投稿日:2019-08-19T16:57:52+09:00

pythonのnp.array配列に格納した2次元座標から、入力した座標に最も近い座標を取得した際の備忘録です

目的

pythonのnp.array配列に格納した2次元座標から、入力した座標に最も近い座標を取得した際の備忘録です

コード

sample.py#!/usr/bin/env python3 # -*- coding: utf-8 -*- import numpy as np PI = 3.1415 coordinate = np.array([ # x, y, th [0.5, 0, PI], [0.9, 0, PI], [0.9, -0.5, PI], [0.9, 0.5, PI], [0.9, 0, PI], [0, 0.5, -1*PI/2], [0, 0.5, 0], [0, 0.5, PI], [-0.5, 0, 0], [-0.9, 0, 0], [-0.9, 0.5, 0], [-0.9, -0.5, 0], [-0.9, 0, 0], [0, -0.5, PI/2], [0, -0.5, 0], [0, -0.5, PI], [0, -0.5, PI/4] ]) # 点p0に一番近い点を取得 def func_search_neighbourhood(p0, ps): L = np.array([]) for i in range(ps.shape[0]): norm = np.sqrt( (ps[i][0] - p0[0])*(ps[i][0] - p0[0]) + (ps[i][1] - p0[1])*(ps[i][1] - p0[1]) ) L = np.append(L, norm) return np.argmin(L) ,ps[np.argmin(L)] def main(): # target coordinate _x = 0 _y = -0.7 target_coor = np.array([_x, _y]) idx, nearrest_coor = func_search_neighbourhood(target_coor, coordinate) print( len( coordinate ) ) print( idx, nearrest_coor[0], nearrest_coor[1], nearrest_coor[2] ) # idx, (x, y, th) if __name__ == '__main__': main()実行結果

$ python sample.py 17 13 0.0 -0.5 1.57075参考

Python/NumPyで2点間の距離を計算

辞書内のPythonの最も近い座標

Python/Numpyで最も近い点を探索

Finding the closest point to a list of points

- 投稿日:2019-08-19T16:47:56+09:00

M5StickVの起動音がうるさいので黙らせた話

概要

M5StickV 買っちゃいました。

で、とりあえず色々遊ぼうと思ったんですけど、こいつ、、

起動したら「ピコーン!」

充電しようと思ってケーブル挿したら「ピコーン!」

再起動したら「ピコーン!」

って、ピコーン!ピコーン!うるさいんですよ。

というわけで、まずは静かにさせることにしました。WAV ファイルを鳴らさなければいい

結論としてはこれだけ。flash に書かれている boot.py の WAV ファイル鳴らしているところを消せばいいんですけど、なかなかいうことを聞いてくれない。

uPyLoader を使ってみた → 不安定

本体フラッシュの boot.py を書き換えるのに uPyLoader をお勧めしている記事が何個か見つかったので試してみたのですが、どうにも不安定。書き込みが成功したり失敗したり、というか、一度だけ書き込みが成功して、それ以降失敗続きです。書き込み成功した1回はいったい何だったのだろう、、?

ampy も使ってみた → GETできない

ampy も使ってみたのだけど、あまり状況変わらず。

> ampy ls /flashとかでファイル一覧は取得できるのだけど、> ampy get /flash/boot.pyだとエラーを吐いて止まる。使い方が違うのかな?(よく分かってない)シリアル接続して pye コマンド【成功】

TeraTerm でシリアル接続してコマンドラインから

>>> pye('/flash/boot.py')で書き換えるのが結局安定してて一番早かった。

書き換えに成功するなら後は簡単。boot.pytry: player = audio.Audio(path = "/flash/ding.wav") #player.volume(100) player.volume(10) wav_info = player.play_process(wav_dev) wav_dev.channel_config(wav_dev.CHANNEL_1, I2S.TRANSMITTER,resolution = I2S.RESOLUTION_16_BIT, align_mode = I2S.STANDARD_MODE) wav_dev.set_sample_rate(wav_info[1]) while True: ret = player.play() if ret == None: break elif ret==0: break player.finish() except: pass30行目くらいから起動音の再生処理が書いてあるので、この辺を消せばいいんだけど、簡単に音量を 100 → 10 に変更してみた。このくらいの音量にすると全然聞こえない。もう少し大きくてもいいかもしれない。

まとめ

boot.py の簡単な修正なら pye コマンドが簡単だった。

uPyLoader や ampy での書き換えがうまくいかないのがイマイチ納得いかないのでもうちょっと試してみようと思う。今後必要になるだろうし、、(上手くいかない理由をご存知の方いらっしゃいましたら教えてください m(_ _)m

- 投稿日:2019-08-19T16:30:01+09:00

重み付き線形回帰を題材に双対表現を堪能しよう

はじめに

ぶっちゃけ回帰における基底関数表現の式とカーネル関数表現の式を毎回忘れるので、どこかにメモを残しておこうってことで記事を書こうと思った次第です。ただまぁ単に覚書にするのは勿体無い気がしたので、簡単な解説記事にしてみました。

覚書用

簡潔にまとめたバージョン。忙しい人もしくは私と同様に思い出したい人用

目的関数

\begin{align*} F &= \frac{1}{2} \left( \mathbf{y} - X \mathbf{w} \right)^T G \left( \mathbf{y} - X \mathbf{w} \right) + \frac{1}{2} \mathbf{w} ^T H \mathbf{w} \\ \end{align*}$\mathbf{y} = (y_1, \dots, y_N)^T \in \mathbb{R} ^N$:出力データ($y_n \in \mathbb{R}$)

$X = (\mathbf{x}_1, \dots, \mathbf{x}_N)^T \in \mathbb{R} ^{N \times D}$:入力データ($\mathbf{x}_n \in \mathbb{R}^D$)

$\mathbf{w} \in \mathbb{R} ^D$:パラメータ

$G \in \mathbb{R} ^{N \times N}$:データの重み(対角行列)

$H \in \mathbb{R} ^{D \times D}$:正則化項の重み(対角行列)最適化

パラメータ

・基底関数表現\begin{align*} \hat{\mathbf{w}} = \left( X^T G X + H\right)^{-1}X^T G \mathbf{y} \\ \tag{1} \end{align*}・カーネル表現

\begin{align*} \hat{\mathbf{w}} = H^{-1} X^T \left( X H^{-1} X^T + G^{-1} \right)^{-1} \mathbf{y} \\ \tag{2} \end{align*}推定値

・基底関数表現\begin{align*} \hat{\mathbf{y}} &= X \hat{\mathbf{w}} \\ &= X \left( X^T G X + H\right)^{-1}X^T G \mathbf{y} \\ &= X X^{\dagger} \mathbf{y} \\ \end{align*}ただし$X^{\dagger} \triangleq \left( X^T G X + H\right)^{-1}X^T G$

・カーネル関数表現

\begin{align*} \hat{\mathbf{y}} &= X \hat{\mathbf{w}} \\ &= X H^{-1} X^T \left( X H^{-1} X^T + G^{-1} \right)^{-1} \mathbf{y} \\ &= K \left( K + G \right)^{-1} \mathbf{y} \end{align*}ただし$K \triangleq X H^{-1} X^T$

解説

重み付き線形回帰の背景

本題は双対表現を得ることなので、重み付き線形回帰自体の説明はさらっとします。

まず重み付き線形回帰を一言で言うと「重み付き線形回帰はデータの信頼度がわかってる場合や特定のデータだけは誤差を小さくしたい場合とかに使える回帰手法」です。

通常の回帰では入力$\mathbf{x}_n$と出力$y_n$のペアが$N$組み与えられた時、以下のような目的関数$F$を\begin{align*} F = \sum_{n=1}^{N} \left( y_n - f( \mathbf{x}_n )\right)^2\\ \end{align*}最小とする関数$f$のパラメータを求めます。つまり全てのデータに対して均等に誤差が小さくなるようにパラメータを求めます。

対して重み付き回帰では、以下のような目的関数になり\begin{align*} F = \sum_{n=1}^{N} g _n \left( y_n - f( \mathbf{x}_n) \right)^2\\ \end{align*}各データに対して解析者が重み$g _n$を与えることで、どのデータについて誤差を小さくしたいかを各データごとに任意で決めることができます。つまり重み付き回帰では重み付きの誤差が小さくなるように関数$f$のパラメータを求めます。もちろん全ての重みが一定$g _n = {\rm constant}$のとき通常の回帰と一致します。

このような各データに対して重みをつけたいという状況はままあります。

例えば各都市にある工場の数から空気中の化学物質暴露量を予想したい状況を考えてみましょう。

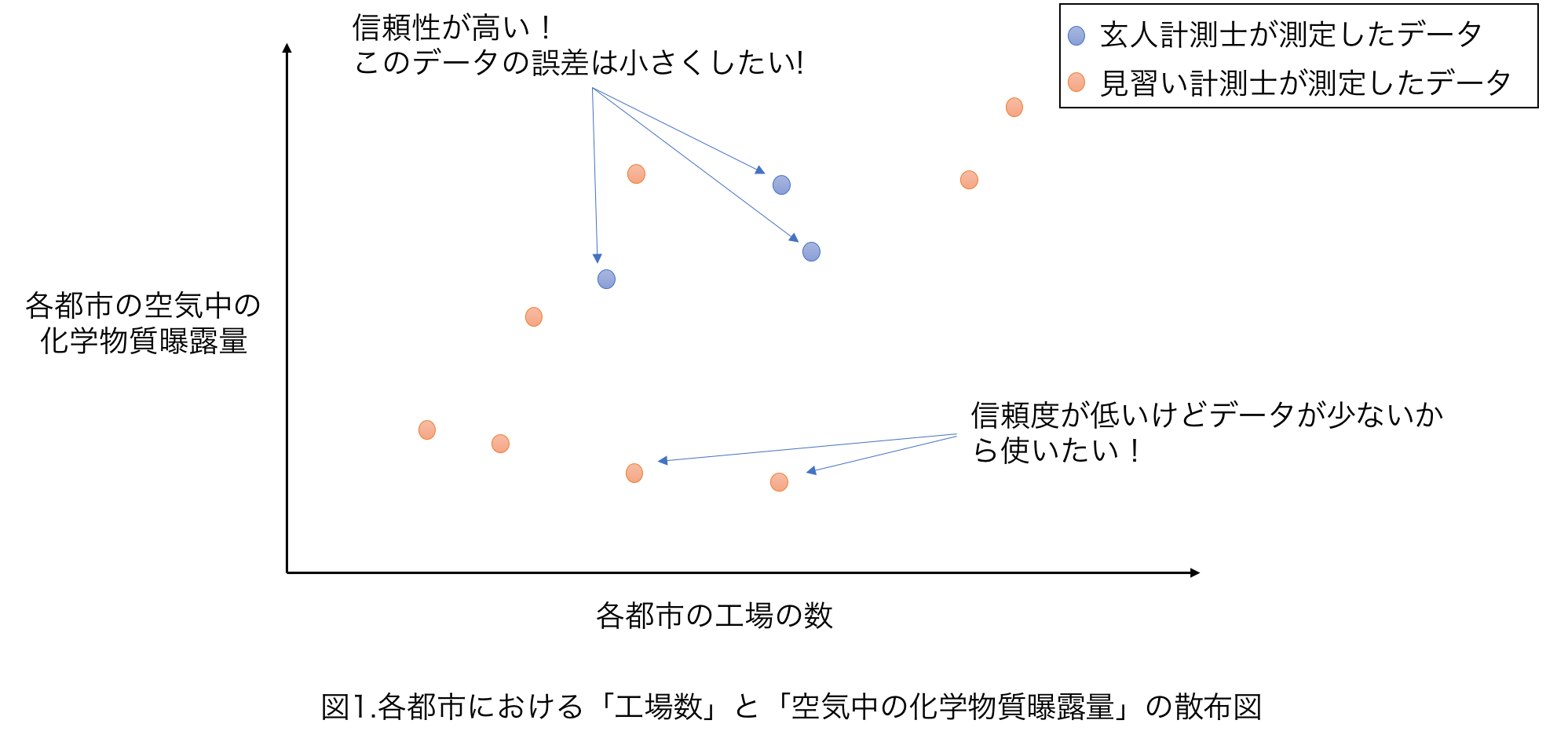

空気中の化学物質暴露量の測定には技術が必要で、玄人計測士はかなりよい精度で測定することができますが、忙しく何箇所も測定することが難しいとしましょう。逆に見習い測定士は測定精度は低いですが、手が空いており多くの都市を測定できるとします(図11)。

このような玄人計測士が測定したデータは信頼できるため、誤差をなるべく小さく(重み$g$を大きく)したいといった状況の時、重み付き回帰がなかなか使えます。重み付き線形回帰の問題設定

それでは本題の双対表現を得るために、ちゃっちゃか式変形をしていきます。

重み付き線形回帰のタスクは$N$個の入力$\mathbf{x}_n \in \mathbb{R}^D$と出力$y_n \in \mathbb{R}$のペアと、各データに対する重み$G = {\rm diag}(g _1, \dots, g _N)$が与えられた時に、以下の目的関数を最小とするようなパラメータ$\mathbf{w}$を求めることになります。\begin{align*} F = \frac{1}{2} \left( \mathbf{y} - X \mathbf{w} \right)^T G \left( \mathbf{y} - X \mathbf{w} \right) + \frac{\beta}{2} \mathbf{w}^T \mathbf{w} \\ \tag{3} \end{align*}ここで$X$は入力$\mathbf{x} _n$を並べた行列$X = (\mathbf{x}_1, \dots, \mathbf{x} _N)\in \mathbb{R} ^{D \times N}$で、$\mathbf{y}$は出力$y _n$を並べたベクトル$(y _1, \dots, y _N) \in \mathbb{R} ^N$です。

解いてみた

最小二乗法でおなじみの式(3)を$\mathbf{w}$で偏微分して$0$とおくことで、最適なパラメータを求めましょう。

\begin{align*} \frac{\partial F}{\partial \mathbf{w}} &= \frac{\partial }{\partial \mathbf{w}} \left\{ \frac{1}{2} \left( \mathbf{y} - X \mathbf{w} \right)^T G \left( \mathbf{y} - X \mathbf{w} \right) + \frac{\beta}{2} \mathbf{w}^T \mathbf{w} \right\} \\ &= \frac{\partial }{\partial \mathbf{w}} \left\{ \frac{1}{2} \left( \mathbf{y}^T G \mathbf{y} - 2 \mathbf{w}^T X^T G \mathbf{y} + \mathbf{w}^T X^T G X\mathbf{w} \right) + \frac{\beta}{2} \mathbf{w}^T \mathbf{w} \right\} \\ &= - X^T G \mathbf{y} + X^T G X \mathbf{w} + \beta \mathbf{w} \\ &= - X^T G \mathbf{y} + \left( X^T G X + \beta I \right) \mathbf{w} \\ &= 0 \end{align*}より

\begin{align*} \left( X^T G X + \beta I \right) \hat{\mathbf{w}} = X^T G \mathbf{y} \\ \hat{\mathbf{w}} = \left( X^T G X + \beta I \right)^{-1} X^T G \mathbf{y} \tag{4} \end{align*}となり、パラメータが推定できました!

次はメインディッシュの双対表現を求めていきましょう!

通常は$\mathbf{w} = \alpha X$とおいて、$\alpha$について解いていき双対表現を求めていきますが、

今回は逆行列の補助定理(Sherman–Morrison–Woodburyの公式)1を使って求めていきます。

まず、$H \triangleq \beta I$とおき式(4)を\begin{align*} \hat{\mathbf{w}} &= \left( X^T G X + H \right)^{-1} X^T G \mathbf{y} \\ &= \left( H + X^T G X \right)^{-1} X^T G \mathbf{y} \tag{5} \end{align*}と書きなおします。

ここでpush through identity(証明)\begin{align*} \left( A + BCD \right)^{-1} B = A^{-1}B \left( DA^{-1}B + C^{-1} \right)^{-1} C^{-1} \\ \end{align*}を使って式変形をしていきます。$A = H、B = X^T,C = G, D = X$とみなすと式(5)は

\begin{align*} \hat{\mathbf{w}} &= \left( H + X^T G X \right)^{-1} X^T G \mathbf{y} \\ &= H^{-1}X^T \left( XH^{-1}X^T + G^{-1} \right)^{-1} G^{-1} G \mathbf{y} \\ &= H^{-1}X^T \left( XH^{-1}X^T + G^{-1} \right)^{-1} \mathbf{y} \tag{6} \end{align*}となり、双対表現が得られました!!

ちなみに式(6)の結果を使って新規入力に対する出力の予測値$\hat{\mathbf{y}}$を求めて見ると\begin{align*} \hat{\mathbf{y}} &= X \hat{\mathbf{w}} \\ &= X H^{-1}X^T \left( XH^{-1}X^T + G^{-1} \right)^{-1} \mathbf{y} \\ \end{align*}となります。またここで$K \triangleq X H^{-1}X^T$とおくと

\begin{align*} \hat{\mathbf{y}} = K \left( K + G^{-1} \right)^{-1} \mathbf{y} \\ \end{align*}となり、みなさんがよく目にする式になります。

実装編

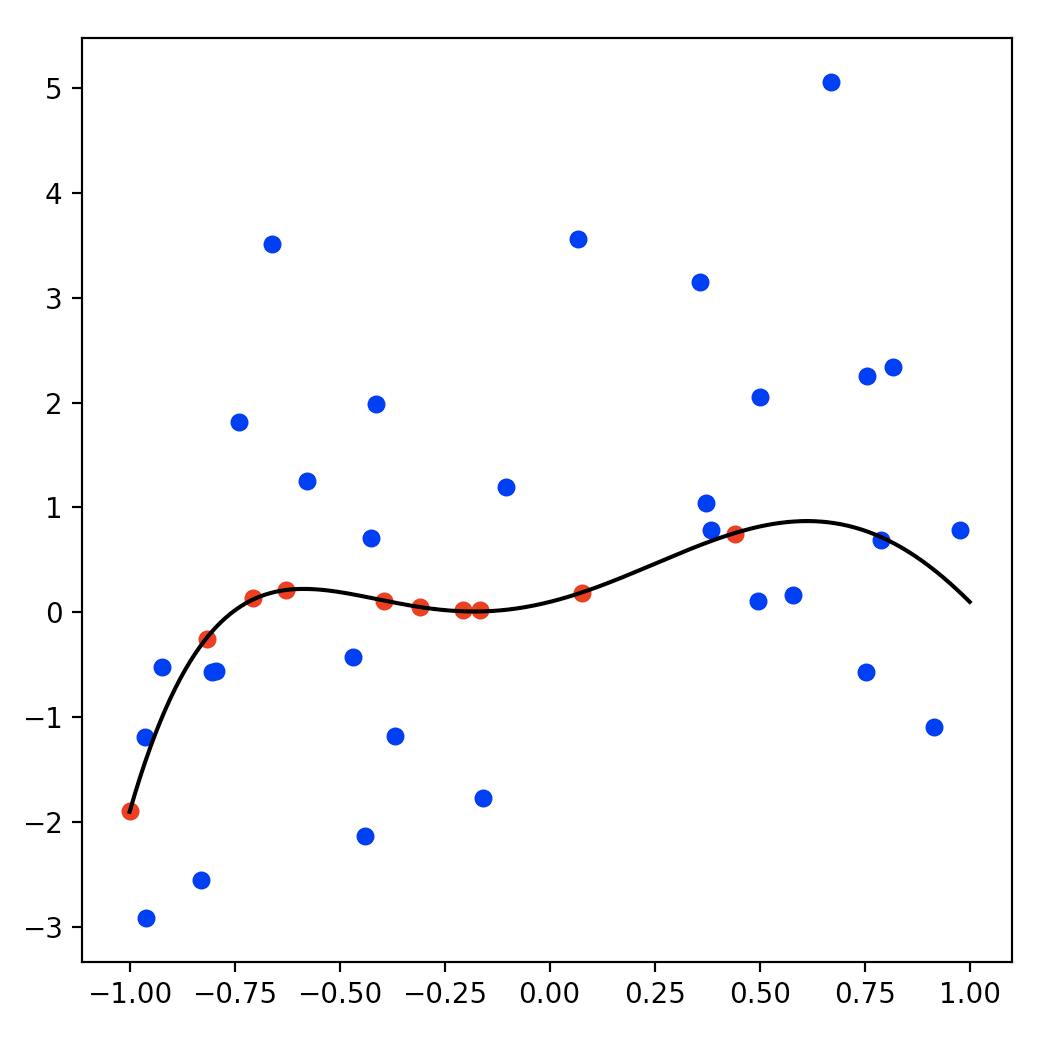

いま、信頼性が高いデータが10点(赤点)と信頼性が低いデータが30点(青点)与えられた時の回帰をやってみましょう。

データは以下のようになります。横軸が入力で縦軸が出力です。

黒線が真の関数を表してます。

このデータに対して、重み付き回帰を行ってみましょう!

コードは以下のようになります。import numpy as np import matplotlib.pyplot as plt np.random.seed(1) # ---------- データ生成 ---------- # M = 5 w = np.array([0.1, 1.0, 2.5, -2.0, -3.5, 2.0]) # 真の関数のパラメータ power = np.arange(M+1) # 信頼性が高いデータ(ノイズの分散0.01) N1 = 10 x1 = (np.random.rand(N1) * 2 - 1)[:, np.newaxis] y1 = x1**power @ w + np.random.normal(0, 0.01, N1) # 信頼性が低いデータ(ノイズの分散2.0) N2 = 30 x2 = (np.random.rand(N2) * 2 - 1)[:, np.newaxis] y2 = x2**power @ w + np.random.normal(0, 2.0, N2) # 連結 N = N1 + N2 x = np.concatenate([x1, x2]) y = np.concatenate([y1, y2]) # 真の関数 x_all = (np.linspace(-1, 1, 500))[:, np.newaxis] true_y = x_all**power @ w # ---------- データの重みと正則化項 ---------- # g1 = np.ones(N1) * 100.0 # 重みはノイズの分散の逆数が良き g2 = np.ones(N2) * 0.5 beta = 0.1 G = np.diag(np.concatenate([g1, g2])) H = np.eye(M+1) * beta # ---------- パラメータ推定 ---------- # # 基底関数の準備(M次多項式) Phi = x**power # 通常のリッジ回帰 w = np.linalg.pinv(Phi.T @ Phi + H) @ Phi.T @ y f = x_all**power @ w # 重み付き回帰 w_weight_regression = np.linalg.pinv(Phi.T @ G @ Phi + H) @ Phi.T @ G @ y f_weight_regression = x_all**power @ w_weight_regression # 信頼度の高いデータだけ使った場合 Phi_x1_only = x1**power w_x1_only = np.linalg.pinv(Phi_x1_only.T @ Phi_x1_only + H) @ Phi_x1_only.T @ y1 f_x1_only = x_all**power @ w_x1_only # ---------- 描画 ---------- # fig = plt.figure(figsize=(6, 6)) ax = fig.add_subplot(1, 1, 1) ax.scatter(x1, y1, s=30, c='red') ax.scatter(x2, y2, s=30, c='blue') ax.plot(x_all, true_y, c='black') # 真の関数 ax.plot(x_all, f, c='green') # 普通のリッジ回帰 ax.plot(x_all, f_weight_regression, c='yellow') # 重み付き回帰 ax.plot(x_all, f_x1_only, c='pink') # 信頼性の高いデータだけ使ったリッジ回帰 plt.show()結果がこちらになります。黄色の曲線が重み付き回帰で求めたパラメータを使った関数です。

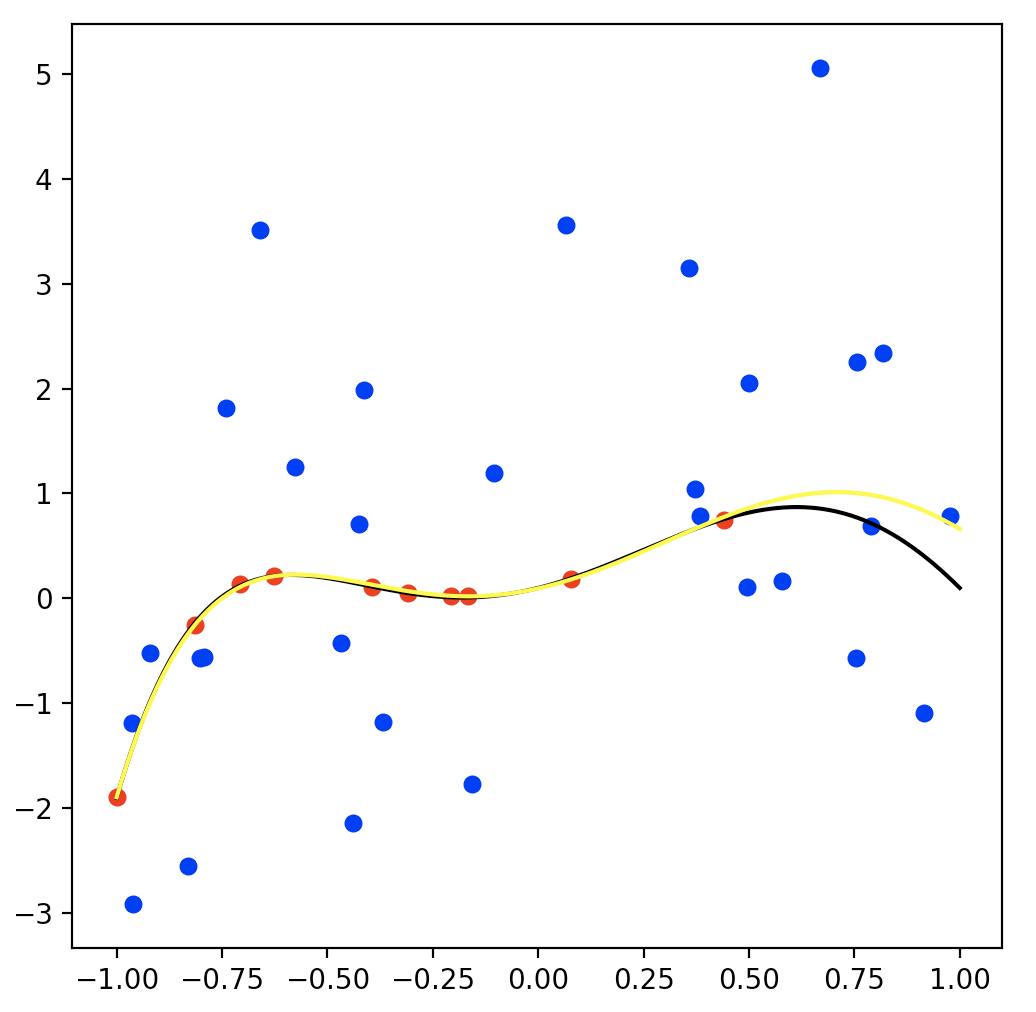

まぁまぁ真の関数を表現できてますね。やった。

ちなみに比較対象として、「普通のリッジ回帰(緑)」と「信頼性の高いデータだけ使ったリッジ回帰(ピンク)」を一緒に実行した結果がこちらです。

普通のリッジ回帰の結果(緑)は信頼性の低いデータ(青点)に引っ張られている感じで、重み付き回帰より真の関数がうまく推定できてないですね。

信頼性の高いデータだけ使ったリッジ回帰の結果(ピンク)はデータ点があるところは真の関数と近いですが、右の方のデータ点が存在しないところは少し真の関数からずれてますね。

こんな感じで、データの信頼度(ノイズの大きさ)がわかっている場合では重み付き回帰が効果的なのがわかりますね。おまけ1:GとHの解釈について

結論から言うと実は$G = {\rm diag}(g _1, \dots, g _N)$の$g _n$は$n$番目のデータに乗っているガウスノイズの精度パラメータと解釈することができます。また$H = \beta I$の$\beta$は関数パラメータ$\mathbf w$の事前分布(ガウス分布)の精度パラメータと解釈できます。

つまり、$G$はデータのノイズの大きさを表現しており$H$は関数(パラメータ)の取りうる範囲を表現しているといった風になります。

なぜこのように解釈できるかはベイズ回帰(MAP推定)を考えてみるとわかりやすいので、簡単にですがみていきましょう。

まず、観測データ$\left( \mathbf{x} _n, y _n \right) _{n=1}^{N}$に対して以下のような確率モデルを考えます。\begin{align*} & y_n = \mathbf{w}^T \mathbf{x}_n + \epsilon_n \\ & \epsilon \sim N(0, \alpha^{-1}) \tag{7}\\ & \mathbf{w} \sim N(0, \beta^{-1}I) \tag{8}\\ \end{align*}ここで推定したいパラメータ$\mathbf{w}$の対数事後分布はベイズの公式より

\begin{align*} \ln p(\mathbf{w}|\mathbf{y}, X) &= \ln \frac{p(\mathbf{y}|\mathbf{w}, X)p(\mathbf{w})}{p(\mathbf{y}|X)} \\ &= \ln p(\mathbf{y}|\mathbf{w}, X) + \ln p(\mathbf{w}) - \ln p(\mathbf{y}|X) \tag{9} \end{align*}となります。また

\begin{align*} & p(\mathbf{y}|\mathbf{w}, X) = \prod _n p(\mathbf{y}_n|\mathbf{w}, \mathbf{x}_n) = \prod _n N(\mathbf{w}^T \mathbf{x}_n, \alpha^{-1}) \\ & p(\mathbf{w}) = N(0, \beta^{-1}I) \end{align*}であるから、式(9)は

\begin{align*} \ln p(\mathbf{w}|\mathbf{y}, X) &= \ln N(\mathbf{w}^T \mathbf{x}_n, \alpha^{-1}) + \ln N(0, \beta^{-1}I) - \ln p(\mathbf{y}|X) \\ &= -\frac{\alpha}{2} \| \mathbf{y} - X \mathbf{w} \|^2 - \frac{\beta}{2}\| \mathbf{w} \| + C \end{align*}となります。2ただし$C$は$\mathbf{w}$について定数となるものをまとめた係数です。

さらに$G = \alpha I$とおき$H = \beta I$とおくと、\begin{align*} \ln p(\mathbf{w}|\mathbf{y}, X) = - \left( \mathbf{y} - X \mathbf{w} \right)^T G \left( \mathbf{y} - X \mathbf{w} \right) - \mathbf{w}^T H \mathbf{w} + C \end{align*}といった、重み付き線形回帰の目的関数とよく似たものがでてきます。

$G=\alpha I$は式(7)からわかるようにノイズの精度パラメータであり、$H=\beta I$は式(8)からわかるようにパラメータ$\mathbf{w}$に関する事前分布のパラメータです。おまけ2:定理とかの証明

push through identityの証明

まず$B + BCDA^{-1}B$っていう天から落ちて来た式を左から$BC$でくくると

\begin{align*} B + BCDA^{-1}B = BC \left( C^{-1} + DA^{-1}B \right) \end{align*}となります。また同じものを右から$A^{-1}B$でくくると

\begin{align*} B + BCDA^{-1}B = \left( A + BCD \right) A^{-1}B \end{align*}となり、

\begin{align*} BC \left( C^{-1} + DA^{-1}B \right) = \left( A + BCD \right) A^{-1}B \end{align*}という等式が得られます。そして両辺に対して右から$\left( C^{-1} + DA^{-1}B \right)^{-1}$と左から$\left( A + BCD \right)^{-1}$をそれぞれ掛けると

\begin{align*} \left( A + BCD \right)^{-1} BC \left( C^{-1} + DA^{-1}B \right) \left( C^{-1} + DA^{-1}B \right)^{-1} &= \left( A + BCD \right)^{-1} \left( A + BCD \right) A^{-1}B \left( C^{-1} + DA^{-1}B \right)^{-1}\\ \left( A + BCD \right)^{-1} BC &= A^{-1}B \left( C^{-1} + DA^{-1}B \right)^{-1} \end{align*}となります。

さらにこれに右から$C^{-1}$を掛けてあげると\begin{align*} \left( A + BCD \right)^{-1} B = A^{-1}B \left( C^{-1} + DA^{-1}B \right)^{-1} C^{-1} \end{align*}となって、証明終了

ちなみにpush through identityは逆行列の補助定理(証明)\begin{align*} \left( A + BCD \right)^{-1} = A^{-1} - A^{-1}B \left( DA^{-1}B + C^{-1} \right)^{-1} DA^{-1} \\ \end{align*}と、push through rule(証明)

\begin{align*} A \left( I + BA \right)^{-1} = \left( I + AB \right)^{-1} A \\ \end{align*}を組み合わせたもので、証明の手順はpush through ruleにならってます。

逆行列の補助定理の証明

実際に積をとって単位行列になるか確認します。

途中、ごちゃごちゃしてるようにみえるけど単に分配法則を適用してるだけです。\begin{align*} \left( A + BCD \right) \left[ A^{-1} - A^{-1}B \left( DA^{-1}B + C^{-1} \right)^{-1} DA^{-1} \right] &= \left\{ I - B \left( DA^{-1}B + C^{-1} \right)^{-1} DA^{-1}\right\} \\ & + \left\{ BCDA^{-1} - BCD A^{-1}B \left( DA^{-1}B + C^{-1} \right)^{-1} DA^{-1} \right\} \\ &= \left\{ I + BCDA^{-1} \right\} \\ & - \left\{ B \left( DA^{-1}B + C^{-1} \right)^{-1} DA^{-1} + BCD A^{-1}B \left( DA^{-1}B + C^{-1} \right)^{-1} DA^{-1} \right\} \\ &= I + BCDA^{-1} - \left( B + BCD A^{-1}B \right) \left( DA^{-1}B + C^{-1} \right)^{-1} DA^{-1} \\ &= I + BCDA^{-1} - BC \left(C^{-1} + D A^{-1}B \right) \left( DA^{-1}B + C^{-1} \right)^{-1} DA^{-1} \\ &= I + BCDA^{-1} - BCDA^{-1} \\ &= I \\ \end{align*}証明終了

push through ruleの証明

まず、$A + ABA$を$A$でくくると

\begin{align*} A + ABA = A \left( I + BA \right) \\ A + ABA = \left( I + AB \right) A \\ \end{align*}となるので、

\begin{align*} A \left( I + BA \right) = \left( I + AB \right) A \\ \end{align*}の等式が得られます。次にそれらに右から$\left( I + AB \right)^{-1}$を掛けると

\begin{align*} A = \left( I + AB \right) A \left( I + BA \right)^{-1} \\ \end{align*}となり、さらに両辺に左から$\left( I + BA \right)^{-1}$を掛けると

\begin{align*} \left( I + BA \right)^{-1} A = A \left( I + BA \right)^{-1} \\ \end{align*}となって証明終了

おまけ3:基底関数のバージョン

目的関数

\begin{align*} F = \frac{1}{2} \left( \mathbf{y} - \Phi \theta \right)^T G \left( \mathbf{y} - \Phi \theta \right) + \frac{1}{2} \theta^T H \theta\\ \end{align*}$\mathbf{y} \in \mathbb{R} ^N$:出力($N$個のデータ)

$\Phi \in \mathbb{R} ^{N \times M}$:計画行列($M$個の基底関数)

$\theta \in \mathbb{R} ^M$:パラメータ

$G \in \mathbb{R} ^{N \times N}$:データの重み(対称行列)

$H \in \mathbb{R} ^{M \times M}$:正則化項の重み(対称行列)推定したパラメータ

・基底関数表現\begin{align*} \hat{\theta} = \left( \Phi^T G \Phi + H\right)^{-1}\Phi^T G \mathbf{y} \\ \end{align*}・カーネル表現

\begin{align*} \hat{\theta} = H^{-1} \Phi^T \left( \Phi H^{-1} \Phi^T + G^{-1} \right)^{-1} \mathbf{y} \\ \end{align*}

- 投稿日:2019-08-19T14:03:01+09:00

Pythonの強化学習ライブラリKeras-RLのパラメータ設定

はじめに

PythonライブラリKeras-RLは強化学習のことがあまりわかっていなくても使えてしまうのですが、

細かいチューニングをしようと思うとパラメータの意味を理解していないといけません。そうすると強化学習の数式レベルの理解がある程度必要になります

(行動価値関数などの最終的な式の意図や動作が把握できている程度でよい)。よくわかっていないという人は個人的には以下の連載記事が一番わかりやすかったのでおすすめです。

今さら聞けない強化学習(1):状態価値関数とBellman方程式

本記事では、Keras-RLの各パラメータがどのような意味を持つのかを説明しながら、

実際の設定値などを紹介していきたいと思います。(私も完全に理解している訳ではないので誤りがありましたらコメントいただければと思います)

想定読者

- 強化学習の思想やKeras-RLの使い方の流れはわかったけど、細かいパラメータを適当に設定している人

Keras-RLのパラメータ

Keras-RL Documentationの Available Agentsには以下のAgentが利用可能であると記載されています。

- DQN

- DDPG

- NAF

- CEM

- SARSA

また、DDQN(DoubleDQN)とDuelingDQNはDQNのパラメータで設定できます。

数が多いので、ここでは最もメジャーなDQNに絞ってパラメータを見ていきます。

環境、DNNモデル

まずはgymの環境とDNNモデルを作成しておきます。

環境は例としてCartPole-v0とします。from keras.models import Sequential from keras.layers import Dense, Activation, Flatten, Dropout import gym env = gym.make('CartPole-v0') nb_actions = env.action_space.n model = Sequential() model.add(Flatten(input_shape=(1,) + env.observation_space.shape)) model.add(Dense(16)) model.add(Activation('relu')) model.add(Dropout(0.5)) model.add(Dense(16)) model.add(Activation('relu')) model.add(Dense(nb_actions)) model.add(Activation('linear'))DNNの入力層と出力層はニューロン数が固定されます。

DQNのDNNは「環境の観測値に応じた行動価値関数の近似」をするために用いられるので、

「環境で観測される値の次元=env.observation_space.shape」が入力となり、

「行動空間の次元=nb_actions」が出力となります。その間の層は全結合(Dense)やDropout、活性化関数(Activation)を自由に積み重ねてください。

Experience Replay用のメモリ

Experience ReplayとはDNNの学習を安定させるために用いられる仕組みです。

DNNは時系列に相関があるデータをその順番のまま使うとうまく学習できないらしいので、

メモリにaction、reward、observationsなどのデータを経験(Experience)として保管しておいて、後でランダムにデータを再生(Replay)して学習を行います。from rl.memory import SequentialMemory memory = SequentialMemory(limit=50000, window_length=1, ignore_episode_boundaries=False)

パラメータ 必須 意味 limit ○ メモリ(collections.deque)の上限サイズ。action(行動)、reward(報酬)、observations(観測)のそれぞれにdequeが用意される。上限を超えると古いデータが書き換えられていく window_length ○ 観測を何個連結して処理するか。例えば時系列の複数の観測をまとめて1つの状態とする場合に利用。 ignore_episode_boundaries エピソードの境界を無視するかどうか(別のエピソードの経験を利用する場合はTrue)。 なお、もうひとつ

rl.memoryにあるEpisodeParameterMemoryクラスはCEMで利用可能なメモリとのことです。行動ポリシー