- 投稿日:2020-09-13T23:56:39+09:00

【Python】"copy()"したのにコピーされていない?深いコピーに関する思い込みと失敗

投稿日:2020/9/13

はじめに

この記事では参照の代入、浅いコピー、深いコピーについて書いています。すでに複数の記事がありますが、この記事では私が間違いに気づいた時の状況や、その他調べている中で新しく知った内容を含めています。

私は浅いコピーと深いコピーを理解できておらず、参照の代入=浅いコピー、

.copy()=深いコピーであると思っていました。しかし、今回の失敗で調べてみて、代入には3種類あることを知りました。3つの代入

参照の代入

a = [1,2] b = a b[0] = 100 print(a) # [100, 2] print(b) # [100, 2]こうすると、

bを書き換えるとaも書き換わりますよね。これが参照の代入1です。aとbは同じ物(オブジェクト)を指しているため、片方を書き換えるともう片方も書き換わったように見えます。

id()でオブジェクトIDを確認してみましょう。print(id(a)) # 2639401210440 print(id(b)) # 2639401210440 print(a is b) # Trueidが同じですね。

aとbが同じであることがわかります。浅いコピー

では、

bをaとは別のオブジェクトとして扱いたい場合はどうすれば良いでしょうか。私は普段.copy()を使っています。a = [1,2] b = a.copy() # 浅いコピー b[0] = 100 print(a, id(a)) # [1, 2] 1566893363784 print(b, id(b)) # [100, 2] 1566893364296 print(a is b) # Falseちゃんと

aとbが分かれていますね。これが浅いコピーです。浅いコピーは他にも方法があります。リストの浅いコピー# リストの浅いコピー import copy a = [1,2] b = a.copy() # .copy()を使う例 b = copy.copy(a) # copyモジュールを使う例 b = a[:] # スライスを使う例 b = [x for x in a] # リスト内包表記を使う例 b = list(a) # list()を使う例辞書の浅いコピー# 辞書の浅いコピー import copy a = {"hoge":1, "piyo":2} b = a.copy() # .copy()を使う例 b = copy.copy(a) # copyモジュールを使う例 b = dict(a.items()) # items()で取り出したものを辞書にする例深いコピー?

では、深いコピーをやってみましょう。

import copy a = [1,2] b = copy.deepcopy(a) # 深いコピー b[0] = 100 print(a, id(a)) # [1, 2] 2401980169416 print(b, id(b)) # [100, 2] 2401977616520 print(a is b) # False結果は浅いコピーと変わらないですね。

"copy()"したのにコピーされていない

では、次の例はどうでしょうか。

a = [[1,2], [3,4]] # 変更 b = a.copy() b[0][0] = 100 print(a) # [[100, 2], [3, 4]] print(b) # [[100, 2], [3, 4]]一行目の

aを二次元リストにしました。

コピーを取ったはずなのに、aも書き換わっていますね。先程の例との違いはなんでしょうか。ミュータブルオブジェクト

Pythonにはミュータブル(変更可能)オブジェクトとイミュータブル(変更不可能)オブジェクトがあります。分類すると,

ミュータブル:list, dict, numpy.ndarray2など

イミュータブル:int, str, tupleなどという感じです3 4。上の例ではリスト(list)の中にリストを入れています。つまりミュータブルオブジェクトの中にミュータブルオブジェクトを入れました。では、同じオブジェクトかどうかを確認しましょう。

print(a is b, id(a), id(b)) # False 2460506990792 2460504457096 print(a[0] is b[0], id(a[0]), id(b[0])) # True 2460503003720 2460503003720外側のリスト

abは異なりますが、その中のリストa[0]b[0]は同じです。つまり、b[0]を書き換えるとa[0]も書き換わります。よってこの挙動は、オブジェクトの中にミュータブルオブジェクトが入っているのに浅いコピーを使ったことが原因です5。そして、このようなときに用いるのが深いコピーです。

解決策 - 深いコピー

1.深いコピーを使う

深いコピーを使います。

import copy a = [[1,2], [3,4]] b = copy.deepcopy(a) b[0][0] = 100 print(a) # [[1, 2], [3, 4]] print(b) # [[100, 2], [3, 4]]同じオブジェクトかどうかも見てみましょう。

print(a is b, id(a), id(b)) # False 2197556646152 2197556610760 print(a[0] is b[0], id(a[0]), id(b[0])) # False 2197556617864 2197556805320 print(a[0][1] is b[0][1], id(a[0][1]), id(b[0][1])) # True 140736164557088 140736164557088あれ、最後は同じですね。

b[0][1]はイミュータブルオブジェクトであるintであり、再代入時に自動的に別オブジェクトが作られるので問題ありません6。それを除けば、ミュータブルオブジェクトはidが異なるので、コピーされたことがわかります。

2. numpy.ndarrayを使う

今回の内容とは少しずれているということと、余計難しくなるような内容なので、下に持っていきました。「解決策その2 numpy.ndarrayにする」の項を見てください。

私が間違いに気づいたときのコード

私が間違いに気づいた時とほぼ同じコードを掲載します。私は以下のようなデータを作成しました。

import numpy as np a = {"data":[ {"name": "img_0.jpg", "size":"100x200", "img": np.zeros((100,200))}, {"name": "img_1.jpg", "size":"100x100", "img": np.zeros((100,100))}, {"name": "img_2.jpg", "size":"150x100", "img": np.zeros((150,100))}], "total_size": 5000 }このように、辞書の中にリストを、その中に辞書、さらに画像(ndarray)といった感じで、ミュータブルオブジェクトを入れ子にしたデータを作成しました。そして、この中から

imgだけを省いた別の辞書をjson書き出し用に作成しました。その後、元の辞書から

imgを取り出そうとするとKeyErrorが発生しました。コピーしたはずなのにどうしてだろう、としばらく悩んで、辞書の中のオブジェクトの参照が同じである可能性に気づきました。# 問題を起こしたコード data = a["data"].copy() # ここが間違い for i in range(len(data)): del data[i]["img"] # 辞書からimgを削除 b = {"data":data, "total_size":a["total_size"]} # 新しい辞書 img_0 = a["data"][0]["img"] # aを触っていないのにKeyError # KeyError: 'img'解決方法としては

data = copy.deepcopy(a["data"])のように深いコピーに変更するのが一番簡単ですが、この場合、後で消す画像をわざわざコピーすることになり、メモリや実行速度に影響が出る可能性があります。ゆえに、元データから不要なデータを消すのではなく、必要なデータを取り出す形で書くのが良いと思います。

# 必要なデータを取り出す形で書きなおしたコード data = [] for d in a["data"]: new_dict = {} for k in d.keys(): if(k=="img"): # imgだけ含めない continue new_dict[k] = d[k] # コピーではないので注意 data.append(new_dict) b = {"data":data, "total_size":a["total_size"]} # 新しい辞書 img_0 = a["data"][0]["img"] # 動作する私は、コピーしたデータをjson形式で書き出すために使ったので、上のコードで問題ないですが、もしコピー後のデータを書き換えるのであればdeepcopyを使わなければなりません(ミュータブルオブジェクトを含む場合)。

浅いコピーと深いコピー

以上の例からも分かる通り、

浅いコピー:対象のオブジェクトのみ

深いコピー:対象のオブジェクト+対象のオブジェクトに含まれるミュータブルオブジェクト全てがコピーされます。詳しくは、Pythonのドキュメント(copy) をご覧ください。一度目を通しておくと良いと思います。

実行速度検証

テキストを含む辞書

aを作成し、浅いコピーと深いコピーの実行速度テストを行いました。import copy import time import numpy as np def test1(a): start = time.time() # b = a # b = a.copy() # b = copy.copy(a) b = copy.deepcopy(a) process_time = time.time()-start return process_time a = {i:"hogehoge"*100 for i in range(10000)} res = [] for i in range(100): res.append(test1(a)) print(np.average(res)*1000, np.min(res)*1000, np.max(res)*1000)結果

処理 平均(ms) 最小(ms) 最大(ms) b=a 0.0 0.0 0.0 a.copy() 0.240 0.0 1.00 copy.copy(a) 0.230 0.0 1.00 copy.deepcopy(a) 118 78.0 414 適当な検証なのであまりあてになりませんが、浅いコピーと深いコピーの差が大きいことは分かります。よって書き換えしないデータは浅いコピーを使うなど、使用するデータや使用方法によって使い分けたほうがよさそうです。

その他検証等

自作クラスのコピー

import copy class Hoge: def __init__(self): self.a = [1,2,3] self.b = 3 hoge = Hoge() # hoge_copy = hoge.copy() # copyメソッドがないのでエラー hoge_copy = copy.copy(hoge) # 浅いコピー hoge_copy.a[1] = 10000 hoge_copy.b = 100 print(hoge.a) # [1, 10000, 3](書き換わっている) print(hoge.b) # 3 (書き換わっていない)自作クラスの場合も、メンバ変数がミュータブルオブジェクトなら浅いコピーだけでは不十分です。

タプルのコピー

タプルと言っても、タプルの中にミュータブルオブジェクトを入れた場合です。

import copy a = ([1,2],[3,4]) b = copy.copy(a) # 浅いコピー print(a) # ([1, 2], [3, 4]) b[0][0] = 100 # これが実行できる print(a) # ([100, 2], [3, 4])(書き換わっている) b[0] = [100,2] # TypeErrorで書き換え不可タプルはイミュータブルなので値の書き換えができませんが、タプルに含まれるミュータブルオブジェクトの中は書き換えができてしまいます。この場合も同様に浅いコピーでは中のオブジェクトはコピーされません。

リストの

.copy()についてリストのコピー

b = a.copy()について、どのような処理になっているのか気になったので、Pythonのソースコードを見てみました。cpytnon/Objects/listobject.c 812行目 (2020/9/11現在のmasterブランチより引用)

ソースのリンク(位置は変わっているかもしれません)/*[clinic input] list.copy Return a shallow copy of the list. [clinic start generated code]*/ static PyObject * list_copy_impl(PyListObject *self) /*[clinic end generated code: output=ec6b72d6209d418e input=6453ab159e84771f]*/ { return list_slice(self, 0, Py_SIZE(self)); }コメントにもあるように、

Return a shallow copy of the list.

と、浅いコピー(shallow copy)であることが書かれています。その下の実装も

list_sliceと書いてあるので、b = a[0:len(a)]のようにスライスしているだけだと思われます。解決策その2-numpy.ndarrayにする

今回の話とは少しずれますが、多次元配列を扱うのであればリストではなくNumPyのndarrayを使う方法もあります。ただし、注意が必要です。

import numpy as np import copy a = [[1,2],[3,4]] a = np.array(a) # ndarrayに変換 b = copy.copy(a) # b = a.copy() #これでも可 b[0][0] = 100 print(a) # [[1 2] # [3 4]] print(b) # [[100 2] # [ 3 4]]このように、

copy.copy()を使うか、.copy()を使えば問題ありませんが、スライスを使うとリストと同じく、元の配列が書き換わってしまいます。これは、NumPyのcopyとviewの違いによるものです。参考:https://deepage.net/features/numpy-copyview.html (NumPyのコピー(copy)とビュー(view)を分かりやすく解説)

# スライスを使った場合 import numpy as np a = [[1,2], [3,4]] a = np.array(a) b = a[:] # スライス(= viewを作成) # b = a[:,:] # これでも同じ # b = a.view() # これと同じ b[0][0] = 100 print(a) # [[100 2] # [ 3 4]] print(b) # [[100 2] # [ 3 4]]また、この場合は

isによる比較結果がリストと同じようにはなりません。import numpy as np def check(a, b): print(id(a[0]), id(b[0])) print(a[0] is b[0], id(a[0])==id(b[0])) # リストをスライスした場合 a = [[1,2],[3,4]] b = a[:] check(a,b) # 1778721130184 1778721130184 # True True # ndarrayをスライス(viewを作成)した場合 a = np.array([[1,2],[3,4]]) b = a[:] check(a,b) # 1778722507712 1778722507712 # False True最後の行を見ればわかるように、idは同じですが,isによる比較結果がFalseになっています。そのため、

is演算子でオブジェクトの同一性を確認して、Falseであったとしても書き換わってしまうことがあるので注意しなければなりません。

is演算子について調べるとidが同じかどうかを返すと書かれていますが7 8 9、この場合そうはなっていません。numpyが特殊なのでしょうか。よくわかりません。実行環境はPython3.7.4 & numpy1.16.5+mklです。

おわりに

私はこれまで

.copy()で困ったことがなかったので、コピーについて全く気にしたことがありませんでした。これまでに書いたコードの中に、思いがけず書き換えを行っているデータがあるかもしれないと思うと非常に恐ろしいです。Pythonにおけるミュータブルオブジェクトの問題には関数のデフォルト引数の話もあります。こちらも知らないと気づかずに意図しないデータを生成することになるので、ご存知ない方は確認してみてください。

http://amacbee.hatenablog.com/entry/2016/12/07/004510 (Pythonの値渡しと参照渡し)

https://qiita.com/yuku_t/items/fd517a4c3d13f6f3de40 (引数のデフォルト値はimmutableなものにする)# デフォルト引数にミュータブルオブジェクトを指定しないほうが良い def hoge(data=[1,2]): # 悪い例 def hoge(data=None): # 良い例1 def hoge(data=(1,2)): # 良い例2# こういうことも起きる a = [[0,1]] * 3 print(a) # [[0, 1], [0, 1], [0, 1]] a[0][0] = 3 print(a) # [[3, 1], [3, 1], [3, 1]] (全部書き換わっている)参考

[1] https://qiita.com/Kaz_K/items/a3d619b9e670e689b6db (Pythonのcopyとdeepcopyについて)

[2] https://www.python.ambitious-engineer.com/archives/661 (copyモジュール 浅いコピーと深いコピー)

[3] https://snowtree-injune.com/2019/09/16/shallow-copy/ ( Python♪次は理屈で覚えよう「参照渡し」「浅いコピー」「深いコピー」)

[4] https://docs.python.org/ja/3/library/copy.html (copy --- 浅いコピーおよび深いコピー操作)

参照の代入と書きましたが、Pythonにおいてインターネット上でそのような言い方は見つかりませんでした。「参照渡し」は関数の引数で用いられる用語であり、他に良さそうな言い方が見つからなかったので、参照の代入としました。 ↩

ndarrayはイミュータブルにすることも可能らしい(https://note.nkmk.me/python-numpy-ndarray-immutable-read-only/ ) ↩

https://hibiki-press.tech/python/data_type/1763 (主な組み込み型のミュータブル、イミュータブル、イテラブル) ↩

https://gammasoft.jp/blog/python-built-in-types/ (Pythonの組み込みデータ型の分類表(ミュータブル等)) ↩

Pythonのドキュメント には、「複合オブジェクト(リストやクラスインスタンスのような他のオブジェクトを含むオブジェクト)」と書いてあります。よって正確にいうと、複合オブジェクトを浅いコピーしたのが原因です。別項で書きましたが、イミュータブルであるタプルの中にリストを入れても同じことが発生します。 ↩

https://atsuoishimoto.hatenablog.com/entry/20110414/1302750443 (is演算子のふしぎ)Pythonはメモリ削減のためにイミュータブルオブジェクトは使いまわすらしい。 ↩

https://www.python-izm.com/tips/difference_eq_is/ (==とisの違い) ↩

https://qiita.com/i13602/items/6d8914e019c13e858c72 (pythonにおける「==」と「is」の違いについて) ↩

https://docs.python.org/ja/3/reference/expressions.html#is (6.10.3. 同一性の比較)公式リファレンスにも「オブジェクトの同一性はid()関数を使って判定されます。」と書いてある。 ↩

- 投稿日:2020-09-13T23:44:09+09:00

2020年にSelenium (+Python)でスクレイピングしてハマったところ

iframe

症状:「実行画面では表示されているボタンなのにElementが見つからないと言われる!」

→原因と解決策:iframeはいちいち切り替えないとelementが見つけられない

driver.switch_to.frame(driver.find_elements_by_tag_name("iframe")[0]) driver.find_element_by_css_selector("#hogefuga").click() driver.switch_to.default_content()Popupによる干渉

症状:ボタンのelementを取得できているのに押せない

エラー文面:Element <a class="hoge" href="/fuga">...</a> is not clickable at point (748, 591). Other element would receive the click: <div class="piyo">...</div>→原因と解決策:一旦Bodyなどをクリックしておく

driver.find_element_by_tag_name("body").click()

- 投稿日:2020-09-13T23:08:34+09:00

AtCoder Beginner Contest 178 参戦記

AtCoder Beginner Contest 178 参戦記

ABC178A - Not

1分半で突破. xor を使っちゃったけど、タイトルは Not だった(笑).

x = int(input()) print(x ^ 1)ABC178B - Product Max

2分で突破. 端同士のどれかが最大のはずだ.

a, b, c, d = map(int, input().split()) print(max(a * c, a * d, b * c, b * d))ABC178C - Ubiquity

5分で突破. すべての組み合わせの数から、0を含まない組み合わせの数と9を含まない組み合わせの数を引いて、それだと0と9を両方含まない組み合わせの数がダブって引かれているので足し戻したものが答え.

m = 1000000007 N = int(input()) print((pow(10, N, m) - pow(9, N, m) * 2 + pow(8, N, m)) % m)ABC178D - Redistribution

29分で突破. 数列の長さが n の時に S - 3×n を n 個に分配する場合分けの数ってどうするんだって唸っていたら、仕切り棒を入れると思うんだと ABC132D - Blue and Red Balls を思い出して解けた. n種類のものから重複を許してr個選ぶ場合の数はnHr=n+r−1Cr通り.

def make_factorial_table(n): result = [0] * (n + 1) result[0] = 1 for i in range(1, n + 1): result[i] = result[i - 1] * i % m return result def mcomb(n, k): if n == 0 and k == 0: return 1 if n < k or k < 0: return 0 return fac[n] * pow(fac[n - k], m - 2, m) * pow(fac[k], m - 2, m) % m m = 1000000007 S = int(input()) fac = make_factorial_table(S + 10) result = 0 for i in range(1, S // 3 + 1): result += mcomb(S - i * 3 + i - 1, i - 1) result %= m print(result)ABC178E - Dist Max

突破できず. この問題がこんなに解かれているということはと、確信を持って「マンハッタン距離最大」でググったらやっぱりでてきましたね orz.

- 投稿日:2020-09-13T23:02:01+09:00

Keras 多クラス分類 Iris

環境

- Tensorflow 2.3.0

- Google Colaboratory

イントロダクション

- (注意) 重きは、多クラス分類の内容ではなく、tf.kerasを使用した事への内容です

- Tensorflow kerasにより多層パーセプトロン(MLP)を作成

- 簡単なtf.kerasの使い方とモデルの保存、保存したモデルの読込を行う

- kaggleをやっている際、必要にかられ、kerasコードの読み方を今一度確認しました

データセット

- scikit-learnに付属のアヤメ品種データ(Iris plants dataset)を用いて検証

- Irisデータセットには(setosa, versicolor, virginica)の3種の情報が格納されている為、多クラス分類に使える

ソースコード全体

import numpy as np from sklearn.datasets import load_iris from sklearn.model_selection import train_test_split from tensorflow.keras.utils import to_categorical import tensorflow as tf import matplotlib.pyplot as plt # irisデータセット読込 iris = load_iris() # データセットを訓練データ, テストデータに分割 data_X = iris.data data_y = to_categorical(iris.target) # one-hotエンコーディング train_X, test_X, train_y, test_y = train_test_split(data_X, data_y, test_size=0.3, random_state=0) # モデルの構築 model = tf.keras.models.Sequential([ tf.keras.layers.Input(4), tf.keras.layers.Dense(100, activation='relu'), tf.keras.layers.Dense(3, activation='softmax') ]) # モデルのコンパイル model.compile(optimizer=tf.keras.optimizers.Adam(learning_rate=0.01), loss='categorical_crossentropy', metrics=['accuracy']) # モデルの学習 result = model.fit(train_X, train_y, batch_size=32, epochs=50, validation_data=(test_X, test_y), verbose=1) # Accuracyのプロット plt.figure() plt.title('Accuracy') plt.xlabel('epoch') plt.ylabel('accuracy') plt.plot(result.history['accuracy'], label='train') plt.plot(result.history['val_accuracy'], label='test') plt.legend() # Lossのプロット plt.figure() plt.title('categorical_crossentropy Loss') plt.xlabel('epoch') plt.ylabel('loss') plt.plot(result.history['loss'], label='train') plt.plot(result.history['val_loss'], label='test') plt.legend() plt.show() # model.evaluateを使用し、学習を終えたモデルの誤差と精度を呼び出し train_score = model.evaluate(train_X, train_y) test_score = model.evaluate(test_X, test_y) print('Train loss:', train_score[0]) print('Train accuracy:', train_score[1]) print('Test loss:', test_score[0]) print('Test accuracy:', test_score[1]) # 結果の確認(predict) pred_train = model.predict(train_X) pred_test = model.predict(test_X) pred_train = np.argmax(pred_train, axis=1) pred_test = np.argmax(pred_test, axis=1) print(pred_train) print(np.argmax(train_y, axis=1)) print(pred_test) print(np.argmax(test_y, axis=1))データロード

- scikit-learnを使いirisデータのロードを行う

from sklearn.datasets import load_iris # irisデータセット読込 iris = load_iris()# サイズを確認 (iris.data.shape), (iris.target.shape) # ((150, 4), (150,)) print(iris.feature_names) # ラベルの確認 print(iris.data) # 説明変数 print(iris.target_names) # ラベルの確認 print(iris.target) # 目的変数 # データセットのタイプを確認 type(iris.data) type(iris.target) # numpy.ndarray

- 説明変数

['sepal length (cm)', 'sepal width (cm)', 'petal length (cm)', 'petal width (cm)'][[5.1 3.5 1.4 0.2] [4.9 3. 1.4 0.2] [4.7 3.2 1.3 0.2] [4.6 3.1 1.5 0.2] [5. 3.6 1.4 0.2]...

- 目的変数

['setosa' 'versicolor' 'virginica']array([0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2])データ処理

- irisの目的変数をニューラルネットワークで扱いやすいone-hotエンコーディングへ変換

from tensorflow.keras.utils import to_categorical # one-hotエンコーディング data_y = to_categorical(iris.target) # 0 => [1, 0, 0] # 1 => [0, 1, 0] # 2 => [0, 0, 1]

- 以下の様にも記載可能

# 例: クラスベクトル(整数)をバイナリクラス行列に変換 to_categorical(iris.target, num_classes=None, dtype='float32')

詳細は以下参照

https://www.tensorflow.org/api_docs/python/tf/keras/utils/to_categorical続いてデータセットを訓練データ, テストデータへ分割

# データセットを訓練データ, テストデータへ分割 from sklearn.model_selection import train_test_split data_X = iris.data data_y = to_categorical(iris.target) # one-hotエンコーディング train_X, test_X, train_y, test_y = train_test_split(data_X, data_y, test_size=0.3, random_state=0)

- test_size=0.3

- 学習データ7割, テストデータ3割へ分割

- random_state ランダムシードを設定

ネットワークアーキテクチャ

- 入力層 4変数

- 中間層 100変数

- 出力層 3変数

- 活性化関数 relu

- 損失関数 categorical_crossentropy

- 最適化関数Adam

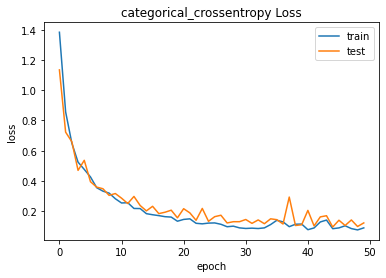

import tensorflow as tf # モデルの構築 model = tf.keras.models.Sequential([ tf.keras.layers.Input(4), tf.keras.layers.Dense(100, activation='relu'), tf.keras.layers.Dense(3, activation='softmax') ]) # モデルのコンパイル model.compile(optimizer=tf.keras.optimizers.Adam(learning_rate=0.01), loss='categorical_crossentropy', metrics=['accuracy']) # モデルの学習 result = model.fit(train_X, train_y, batch_size=32, epochs=50, validation_data=(test_X, test_y), verbose=1)Epoch 1/50 4/4 [==============================] - 0s 36ms/step - loss: 1.0097 - accuracy: 0.5810 - val_loss: 0.7336 - val_accuracy: 0.6222 Epoch 2/50 4/4 [==============================] - 0s 6ms/step - loss: 0.7082 - accuracy: 0.7048 - val_loss: 0.6553 - val_accuracy: 0.6000 Epoch 3/50 4/4 [==============================] - 0s 5ms/step - loss: 0.5494 - accuracy: 0.7905 - val_loss: 0.4738 - val_accuracy: 0.9111

- model.fitのverbose=0を設定する事により途中結果の出力をしない

モデル評価

# model.evaluateを使用し、学習を終えたモデルの誤差と精度を呼び出し train_score = model.evaluate(train_X, train_y) test_score = model.evaluate(test_X, test_y) print('Train loss:', train_score[0]) print('Train accuracy:', train_score[1]) print('Test loss:', test_score[0]) print('Test accuracy:', test_score[1])4/4 [==============================] - 0s 2ms/step - loss: 0.0649 - accuracy: 0.9714 2/2 [==============================] - 0s 2ms/step - loss: 0.1223 - accuracy: 0.9778 Train loss: 0.06492960453033447 Train accuracy: 0.9714285731315613 Test loss: 0.12225695699453354 Test accuracy: 0.9777777791023254# 結果の確認(predict) pred_train = model.predict(train_X) pred_test = model.predict(test_X) pred_train = np.argmax(pred_train, axis=1) pred_test = np.argmax(pred_test, axis=1) print(pred_train) print(np.argmax(train_y, axis=1)) print(pred_test) print(np.argmax(test_y, axis=1))[1 2 2 2 2 1 2 1 1 2 1 2 2 1 2 1 0 2 1 1 1 1 2 0 0 2 1 0 0 1 0 2 1 0 1 2 1 0 2 2 2 2 0 0 2 2 0 2 0 2 2 0 0 1 0 0 0 1 2 2 0 0 0 1 1 0 0 1 0 2 1 2 1 0 2 0 2 0 0 2 0 2 1 1 1 2 2 1 1 0 1 2 2 0 1 1 1 1 0 0 0 2 1 2 0] [1 2 2 2 2 1 2 1 1 2 2 2 2 1 2 1 0 2 1 1 1 1 2 0 0 2 1 0 0 1 0 2 1 0 1 2 1 0 2 2 2 2 0 0 2 2 0 2 0 2 2 0 0 2 0 0 0 1 2 2 0 0 0 1 1 0 0 1 0 2 1 2 1 0 2 0 2 0 0 2 0 2 1 1 1 2 2 1 1 0 1 2 2 0 1 1 1 1 0 0 0 2 1 2 0] [2 1 0 2 0 2 0 1 1 1 2 1 1 1 1 0 1 1 0 0 2 1 0 0 2 0 0 1 1 0 2 1 0 2 2 1 0 2 1 1 2 0 2 0 0] [2 1 0 2 0 2 0 1 1 1 2 1 1 1 1 0 1 1 0 0 2 1 0 0 2 0 0 1 1 0 2 1 0 2 2 1 0 1 1 1 2 0 2 0 0]モデルの保存

# jsonファイルでモデルを保存 # 重みをhdf5で保存 config = model.to_json() with open('model.json','w') as file: file.write(config) model.save_weights('weights.hdf5')モデルの読込

with open('model.json','r') as file: model_json = file.read() model = tf.keras.models.model_from_json(model_json) model.load_weights('weights.hdf5') model.compile(optimizer=tf.keras.optimizers.Adam(learning_rate=0.01), loss='categorical_crossentropy', metrics=['accuracy']) train_score = model.evaluate(train_X, train_y) test_score = model.evaluate(test_X, test_y) print('Train loss:', train_score[0]) print('Train accuracy:', train_score[1]) print('Test loss:', test_score[0]) print('Test accuracy:', test_score[1])4/4 [==============================] - 0s 2ms/step - loss: 0.0649 - accuracy: 0.9714 2/2 [==============================] - 0s 2ms/step - loss: 0.1223 - accuracy: 0.9778 Train loss: 0.06492960453033447 Train accuracy: 0.9714285731315613 Test loss: 0.12225695699453354 Test accuracy: 0.9777777791023254

- tf.keras.models.model_from_jsonについての詳細は以下参照

https://www.tensorflow.org/api_docs/python/tf/keras/models/model_from_json

参考文献

- https://snova301.hatenablog.com/entry/2018/10/29/175028

- https://aidiary.hatenablog.com/entry/20161108/1478609028

おわり (データの中身を把握するには)

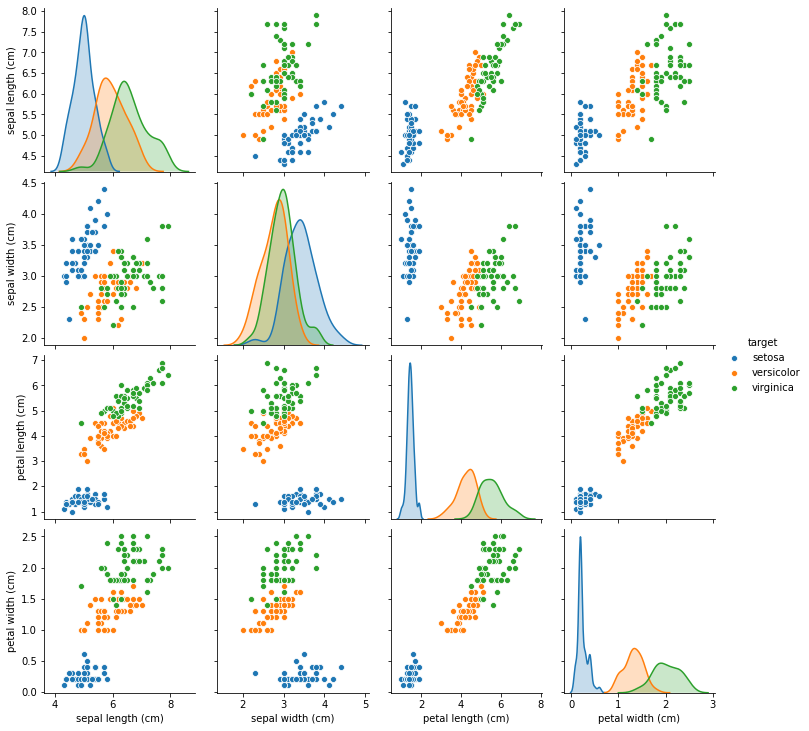

- pandasを使ってみる

- seabornを使ってみる

import pandas as pd import seaborn as sns df = pd.DataFrame(iris.data, columns=iris.feature_names) df['target'] = iris.target df.loc[df['target'] == 0, 'target'] = "setosa" df.loc[df['target'] == 1, 'target'] = "versicolor" df.loc[df['target'] == 2, 'target'] = "virginica" df.head(2)

sepal length (cm) sepal width (cm) petal length (cm) petal width (cm) target 5.1 3.5 1.4 0.2 setosa 4.9 3.0 1.4 0.2 setosa sns.pairplot(df, hue="target")

- 投稿日:2020-09-13T22:58:20+09:00

RustでPythonライクなrangeを使う

はじめに

RustでPythonライクなrangeを使う方法を紹介します。

以下のように使うことができます。

// for i in range(5): // print(i) for i in range!(5) { println!("{}", i); } // for i in range(1, 5): // print(i) for i in range!(1, 5) { println!("{}", i); } // for i in range(1, 5, 2): // print(i) for i in range!(1, 5, 2) { println!("{}", i); } // for i in range(5, 1, -1): // print(i) for i in range!(5, 1, -1) { println!("{}", i); }やり方

以下のマクロでPythonライクなrangeを実装できます。

macro_rules! range { ($stop:expr) => { 0..$stop }; ($start:expr, $stop:expr) => { $start..$stop }; ($start:expr, $stop:expr, -$step:expr) => { ($stop + 1..$start + 1).rev().step_by($step) }; ($start:expr, $stop:expr, $step:expr) => { ($start..$stop).step_by($step) }; }基本的には、Pythonのrange関数と同じイテレータを返します。

できないこと

負のステップを指定するときに、

step_by()はusizeしか受け取れないため、rev()でイテレータを逆順にする必要があります。

そこでパターンマッチで-の有無を判定して、rev()するかを決めています。

なので変数に負の数が入っていてステップとして与えると、パターンマッチで負の数と判定することができないため、コンパイルエラーとなります。// コンパイルエラー let x = -1; for i in range!(5, 1, x) { println!("{}", i); }ここらへんをうまく実装できる方法があれば、教えていただきたいです。

最後に

Rustのマクロは自由度が高いので、とても楽しいです。

- 投稿日:2020-09-13T22:31:54+09:00

ゼロから作るDeep Learning❷で素人がつまずいたことメモ:5章

はじめに

ふと思い立って勉強を始めた「ゼロから作るDeep Learning❷ーー自然言語処理編」の5章で私がつまずいたことのメモです。

実行環境はmacOS Catalina + Anaconda 2019.10、Pythonのバージョンは3.7.4です。詳細はこのメモの1章をご参照ください。

5章 リカレントニューラルネットワーク(RNN)

この章は、リカレントニューラルネットワークの説明です。

5.1 確率と言語モデル

言語モデルの説明と、CBOWを言語モデルに使おうとした時の問題点が解説されています。式5.8が近似になっているのは、CBOWだと単語の並びを無視してしまうからということかと思います。

word2vecは単語の並びを無視してしまうので、分散表現に使うならこの章で学ぶRNNの方が良さそうに思えるのですが、RNNが先に生まれ、語彙数増加と質の向上のために後からword2vecが提案されたとのことで、実際には逆の流れだったというのが興味深いです。

5.2 RNNとは

RNNの解説です。活性化関数としてtanh関数(双曲線正接関数)がでてきますが、なぜかこの本では解説がないので、詳細は「tanh」でググりましょう。

あと少し気になったのは、ミニバッチ学習でデータを終端まで使った時に先頭に戻す対応です。これだとコーパスの末尾と先頭がつながってしまいます。ただ、そもそもこの本ではPTBコーパスを「ひとつの大きな時系列データ」として扱っていて、文の区切りすら意識していません(P.87の中央のサソリマーク部分参照)。そのため、末尾と先頭がつながってしまうことを気にしても意味がないレベルなのかも知れません。

5.3 RNNの実装

実装に当たっては、図5-19と図5-20でバイアス $b$ の後のRepeatノードが省略されているので少し注意が必要です。順伝播はブロードキャストが行われるので図の通りに実装できますが、逆伝播で $db$ を求める際は意識して加算する必要があります。ちょうどこの部分のQAがteratailにもありました(teratail : RNNの逆伝播でdbをaxis=0でsumする理由に関して)。

あと、今回出てきたtanh関数が解説なしで実装されていますが、順伝播は本のコードのように

numpy.tanh()で計算できます。逆伝播はdt = dh_next * (1 - h_next ** 2)の部分がtanhの微分になりますが、これについては本の終わりにある「付録A sigmoid関数とtanh関数の微分」に詳しい解説があります。また、P.205で「...(3点ドット)」の話がでてきますが、これはP.34で出てきた「3点リーダー」と同じです。このメモの1章にも書きましたが、3点ドットだと上書きになると覚えるよりも、ndarrayのスライスとビューの関係を理解するのがオススメです。

5.4 時系列データを扱うレイヤの実装

コードの解説が省略されていますが、シンプルなので見れば理解できました。

Time Embeddingレイヤー(common/time_layers.pyの

TimeEmbeddingクラス)は単純に $T$ 個のEmbeddingレイヤーをループで処理しているだけです。Time Affineレイヤー(common/time_layers.pyの

TimeAffineクラス)では、$T$ 回ループする代わりにバッチサイズ $N$ が $T$ 倍になる形に変形して一気に計算し、結果を元の形に変形することで効率化しています。Time Softmax With Loss レイヤー(common/time_layers.pyの

TimeSoftmaxWithLossクラス)は本の解説通りなのですが、ignore_labelを使ったマスクが実装されているのが気になりました。正解ラベルが -1の場合は損失も勾配も0にして $L$ を求める際の分母の $T$ からも除外しているのですが、正解ラベルを-1にするような処理は今の所なかったかと思います。この後の章で使うのかも知れないので、とりあえず放置しておきます。5.5 RNNLMの学習と評価

残念ながら今回の実装ではPTBデータセット全体を使うと良い結果が出ないとのことなので、前章で遊んだ青空文庫の分かち書き済みテキストでの学習もやめておきました。次章で改良するとのことなので、そこで試してみようと思います。

余談ですが、

SimpleRnnlm.__init__()のrn = np.random.randnというコードを見て、今さらながらPythonは関数を簡単に変数に入れて使えるので便利だなと思いました。C言語だと変数に関数を入れる(関数のエントリポイントを変数に入れる)のに*とか()とかたくさんついて複雑で、それを使うのもややこしくて、現役時代はホント苦手でした5.6 まとめ

なんとか時系列データが取り扱えるようになってきました。

この章は以上です。誤りなどありましたら、ご指摘いただけますとうれしいです。

- 投稿日:2020-09-13T21:53:20+09:00

RとPythonのDocker作業環境の構築2: 日本語対応

はじめに

先日に以下の記事を投稿し,RとPythonが使える環境を構築するDockerfileを紹介しました。

こちらの記事のDockerfileでは,以下の問題がありました。

- 日本語の対応ができていない

- 文字コードが異なっており,他OSのテキスト解析の結果を再現できない

そこで,localeを変更することで,上記問題を解決するDockerfileに修正しました。

FROM ubuntu:18.04 # set timezone RUN apt-get update \ && apt-get install tzdata \ && ln -sf /usr/share/zoneinfo/Asia/Tokyo /etc/localtime RUN date # install packages RUN ["/bin/bash", "-c", "\ apt-get update \ && apt-get install -y \ vim \ build-essential \ git curl llvm sqlite3 libssl-dev libbz2-dev \ libreadline-dev libsqlite3-dev libncurses5-dev \ libncursesw5-dev python-tk python3-tk tk-dev aria2 \ lsb-release locales\ "] RUN locale-gen ja_JP.UTF-8 ENV LANG ja_JP.UTF-8 ENV LANGUAGE ja_JP:ja ENV LC_ALL ja_JP.UTF-8 RUN ["/bin/bash", "-c", "apt-get install -y software-properties-common"] RUN apt-add-repository ppa:ansible/ansible -y # install r RUN apt-key adv --keyserver keyserver.ubuntu.com --recv-keys E298A3A825C0D65DFD57CBB651716619E084DAB9 #RUN add-apt-repository 'deb https://cran.rstudio.com/bin/linux/ubuntu $(lsb_release -cs)-cran35/' RUN add-apt-repository 'deb https://cran.rstudio.com/bin/linux/ubuntu bionic-cran35/' RUN ["/bin/bash", "-c", "\ apt-get update \ && apt-get install -y r-base \ "] RUN Rscript --version CMD ["/bin/bash", "-c"]差分は以下の通りです。

- python3.8 python3-pip のインストールをやめた

- インストールするパッケージにlocalesを追加した

- locale-genから始まるブロックで,日本語に設定した

以上です。

コンテナ上でpyenvを構築するためのスクリプトを作成中で,これができたらとりあえずPCを変えても再現できる環境が作れるのではないかと思っています。

スクリプトができたらまた記事書きます。

- 投稿日:2020-09-13T21:43:38+09:00

画像縮小(LEDマトリクスパネル 16×32)

ppmファイルを縮小して、RGBマトリクスパネル16×32に表示する画像を作ります。

1.ライブラリ

pip install Pillow

resize.pyencoding:UTF-8 #-*- codinf:utf-8 -*- from PIL import Image img = Image.open("{変換前jpgファイル}") width, height = img.size img = img.resize((int(img.width / (img.height / 16 )), 16)) img.save("{変換後ppmファイル}")2.実行

python resize.py

- 投稿日:2020-09-13T21:40:24+09:00

【定義】フレームワークとは何か

はじめに

本記事の主題であるフレームワーク定義の部分は記事の後半部にありますので、前半部は読み飛ばしていただいても問題ありません。

フレームワークを調べるに至るまでの変遷

venvとは何かを調べていたところ、「PyCharmでVenvをGitで共有するときにすること」というサイトを教えてもらったのですが、冒頭の導入部分にこんなことが書いてありました。

今回友達とpythonのDjangoで何かサービスを開発しようということになり、環境はVirtualEnv環境(以降venv)を使おうという話になりました!

venvとは、Djangoを使うときに使えるのか…

いやまず、Djangoってなんだ?

Wikipediaにはこう書かれていました。Django(ジャンゴ)は、Pythonで実装されたWebアプリケーションフレームワーク。

あれ、ウェブアプリケーションフレームワークってなんか聞いたことあるぞ。なんだっけ…

FlaskをWikipediaで調べてみるとこう書かれていました。Flask(フラスク)は、プログラミング言語Python用の、軽量なウェブアプリケーションフレームワークである。標準で提供する機能を最小限に保っているため、自身を「マイクロフレームワーク」と呼んでいる。

そうだ!Flaskもウェブアプリケーションフレームワークなんだ!

flaskってどんな使い方をするんだっけ…

例えば…main.pyfrom flask import Flask app = Flask(__name__, static_folder='.', static_url_path='') @app.route('/') def index(): return app.send_static_file('index.html') app.run(port=8000, debug=True)あれ?つまり、ウェブアプリケーションフレームワークというのはライブラリのことなのか…?

ウェブアプリケーションフレームワーク

じゃあ、ウェブアプリケーションフレームワークって何なんだろう。例によってWikipediaを開きました。

Web アプリケーションフレームワーク(ウェブアプリケーションフレームワーク、英: Web Application Framework)は、動的な ウェブサイト、Webアプリケーション、Webサービスの開発をサポートするために設計されたアプリケーションフレームワークである。

アプリケーションフレームワーク…?

とりあえず続きを読む。フレームワークの目的は、Web開発で用いられる共通した作業に伴う労力を軽減することである。たとえば、多数のフレームワークがデータベースへのアクセスのためのライブラリや、テンプレートエンジン(→Webテンプレート)、セッション管理を提供し、コードの再利用を促進させるものもある。

やっぱりライブラリでもあるんだけど、それだけじゃないみたいだ。

アプリケーションフレームワーク(or フレームワーク)

とりあえずアプリケーションフレームワークとは何か、Wikipediaを読む。

アプリケーションフレームワーク (英: application framework) とは、プログラミングにおいて、アプリケーションソフトウェアの標準構造を実装するのに使われるライブラリ(サブルーチンやクラスなど)の集まりである。単にフレームワークとも呼ぶ。

やっぱりライブラリのことなんだ!

じゃあ、なんでフレームワークなんて言い方をするんだろう…?「ライブラリ」と「フレームワーク」は何が違うのか [本題]

以上がフレームワークとは何かを調べるに至った経緯です。フレームワークとは何かという質問に答えるならば、上記の通り、「誰かが書いたコードの集まり、すなわちライブラリみたいなものと認識しておけば十分」だと思われます。

しかし、このように言葉が分けられているということは、そこに違いがあると考えるのが普通ですよね。こちらの記事によりますと、実は、ライブラリとフレームワークにおける技術的な違いは「制御の反転の有無」という用語に集約されます。これは主導権が「我々」にあるのか、「クラスやサブルーチンの集まり」にあるのかということです。

すなわち、ライブラリを使うときには、ライブラリの機能を使うタイミングは我々が決定するのに対し、フレームワークを使うときには、その機能を使うタイミングをフレームワーク自身が決定するのです。つまり、フレームワークを使う際には、プログラムの制御をするのが使っている人間ではなくそのプログラム自身になってしまうという「制御の反転」ということが起こってくるのです。

ここでもう一度ウェブアプリケーションフレームワークのWikipediaの記事を読んでみると、

フレームワークの目的は、Web開発で用いられる共通した作業に伴う労力を軽減することである。たとえば、多数のフレームワークがデータベースへのアクセスのためのライブラリや、テンプレートエンジン(→Webテンプレート)、セッション管理を提供し、コードの再利用を促進させるものもある。

とありますね。つまり、ライブラリの提供に加えて、テンプレートエンジン(テンプレートエンジンはテンプレートと呼ばれる雛形と、あるデータモデルで表現される入力データを合成し、成果ドキュメントを出力するソフトウェアまたはソフトウェアコンポーネント(Wikipediaより))やセッション管理の提供がなされるとところがよりフレームワーク-likeな部分だと思います。

より詳しい具体例についてはこちらの記事を参照してください。

たとえ話

最後に、引用になりますが、ライブラリとフレームワークの違いのわかりやすいたとえです。

私はよくWeb開発における概念のメタファーとして、家を使います。

例えばライブラリはIKEAに行くようなものです。あなたはすでに自分の家を持っていますが、家具が少し足りないとします。ですが、テーブルを一から作る気にはなれません。そんな時、IKEAに行けば数ある選択肢の中から気に入ったものを持ち帰ることができます。それを選ぶのはあくまでも、あなたです。

一方、フレームワークはモデルハウスを建築するようなものです。いくつかのテンプレートの中から、限られたアーキテクチャとデザインを選ぶことができます。あなたが基本的に選べるのは請負業者とテンプレートのみ。あとはその業者がピンポイントであなたが介入できるところを教えてくれます。

- 投稿日:2020-09-13T21:28:35+09:00

WinAutomationから自分環境のPythonを使う

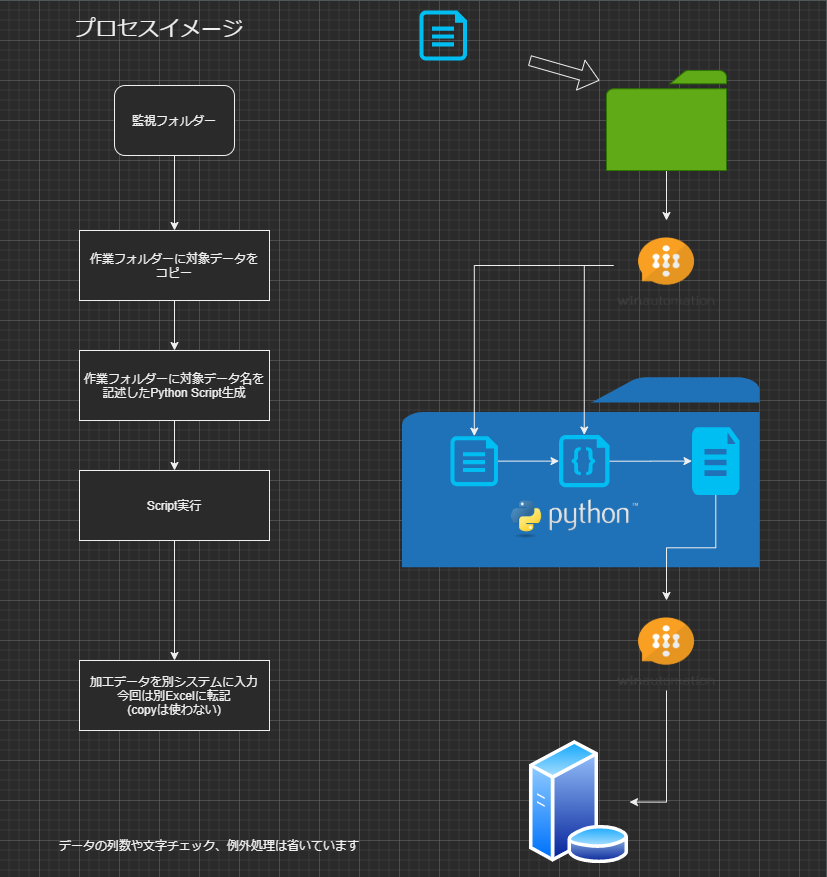

概要

入力処理の自動化をする場合、前処理としてPythonのプロセスを組み込みたいことがあるかもしれません。

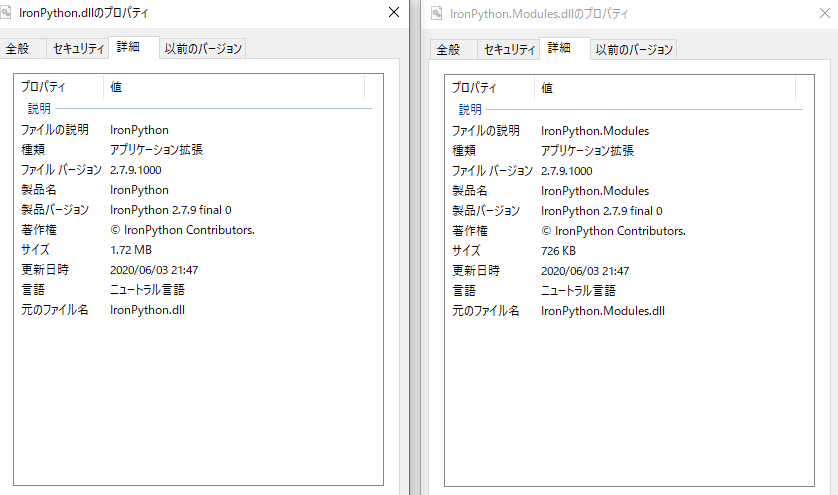

WinAutomationにはPythonアクションがありますがIronPythonというもので、Pandas等ライブラリの使用は難しいようです。

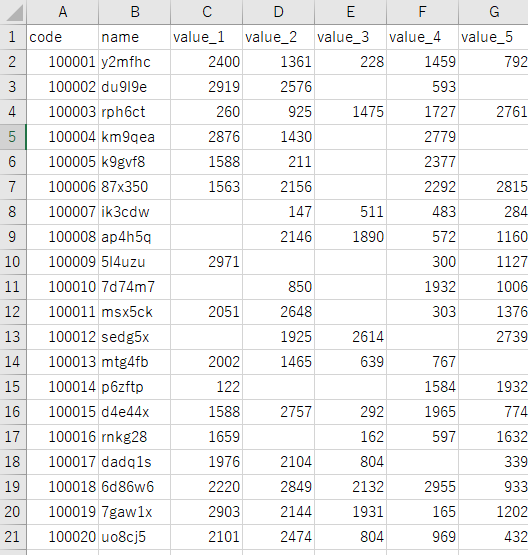

そこで自身が使いたいライブラリをインストールした環境のPythonをWinautomationから実行する方法を説明したいと思います。お題

次ようなnull(空欄)が含まれる1万行のExcelデータを0(ゼロ)で埋めて他システムに入力

0埋めする部分をpython、入力部分はWinautomationで行います(仮想としてExcel to Excel)前提条件

- Windows10 64bit

- WinAutomation 9.2.1

- Python 3.8.5

Python環境構築についてはディストリビューション使用等、様々なお作法があるかもしれませんが、今回は公式版で説明していきます。インストール済みの環境がある場合、複数環境になると正常動作出来なくなる場合がありますので自己責任でお願いいたします。

環境構築

Pythonのインストール

https://www.python.org/

から3.8.5をダウンロード、パスは通さずインストール。

同時にインストールされるランチャーアプリのPy.exeからスクリプトやコマンドの実行を行う。インストール状況とランチャーの動作をバージョン情報を調べて確認

C:\Users\username>py -V Python 3.8.5初期インストールされているライブラリの確認

最新版でないライブラリの確認C:\Users\username>py -m pip list Package Version --------------- ------- pip 20.2.1 setuptools 49.6.0 C:\Users\username>py -m pip list --outdate最新版でなければ両方ともアップデート

C:\Users\user>py -m pip install -U ライブラリ名py -m pip listで再確認

データ処理に必要なライブラリをインストール

今回はデータ処理にpandas、エクセルファイルの読み書きにopenpyxlとxlrdを使用

numpyや他必要ライブラリはpandsインストール時に自動でインストールされるC:\Users\user>py -m pip install pandas C:\Users\user>py -m pip install openpyxl C:\Users\user>py -m pip install xlrd C:\Users\user>py -m pip list Package Version --------------- ------- et-xmlfile 1.0.1 jdcal 1.4.1 numpy 1.19.2 openpyxl 3.0.5 pandas 1.1.2 pip 20.2.3 python-dateutil 2.8.1 pytz 2020.1 setuptools 50.3.0 six 1.15.0 xlrd 1.2.0同様に使いたいライブラリがあれば追加

なおコードエディターにはVisual Studio CodeをしているWinautomationのプロセス

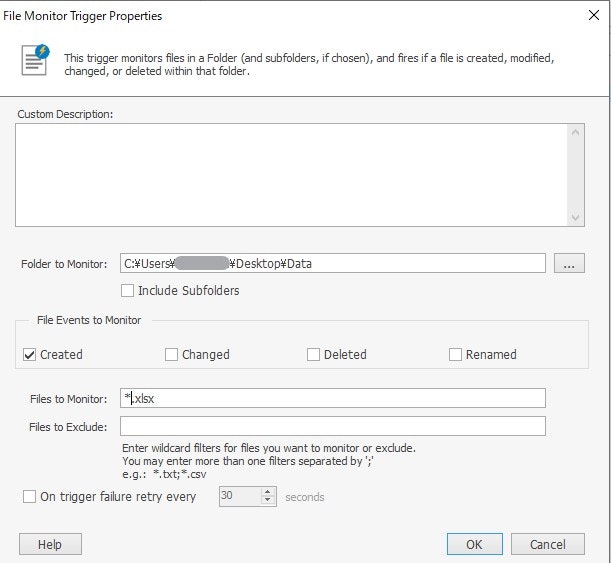

監視フォルダの設定

WinAutomation ConsoleからTriggersでFile Monitor Triggerを設定する

OKしたあと起動するプロセス名を紐づけFile Monitor TriggerのCreatedが起動することで

以下の変数が自動的に値を持つ

Process Designerには表示されない変数なので覚えておくと便利

変数名 内容 %FileTriggerFileName% 拡張子まで含めたファイル名 %FileTriggerFilePath% ファイルの完全なパス及びファイルのすべてのプロパティを保持 %FileTriggerFilePath.NameWithoutExtension% 拡張子を含まないファイル名 プロセスの作成

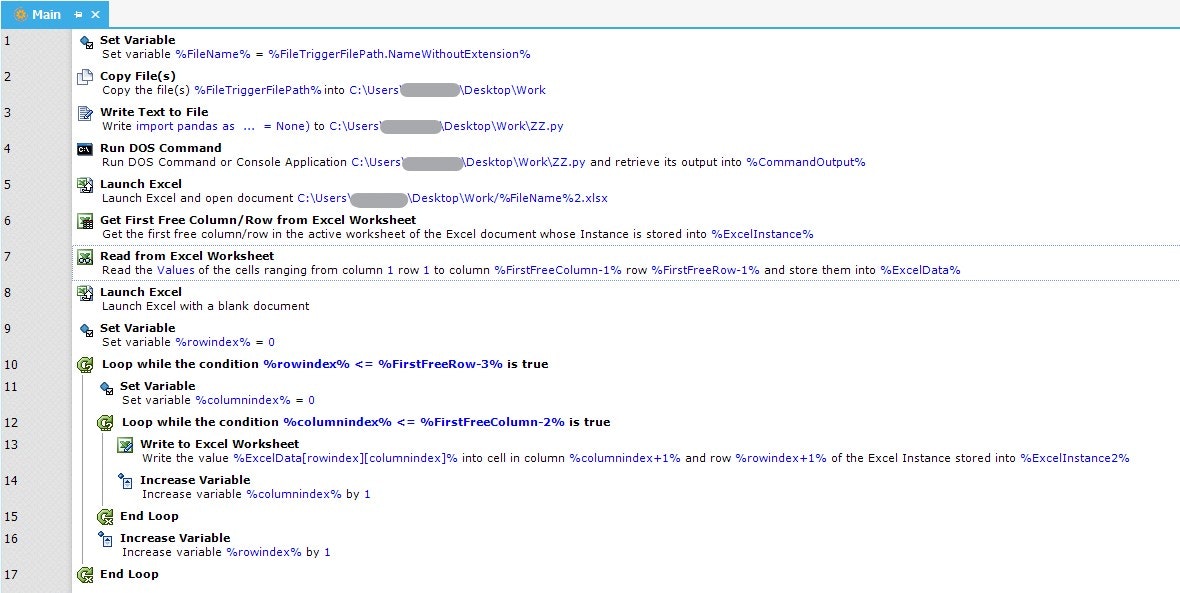

各アクションの解説

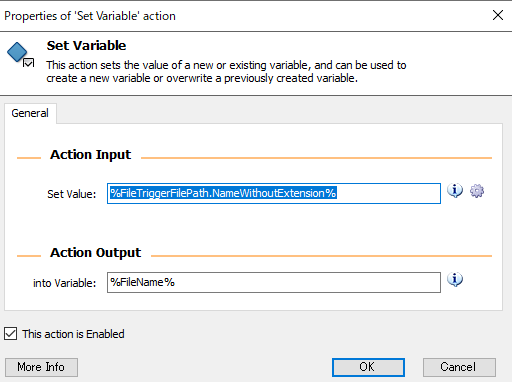

1.Set Variable

File Monitor Triggeから渡されるファイル名の変数が長すぎるのでわかりやすくしただけ

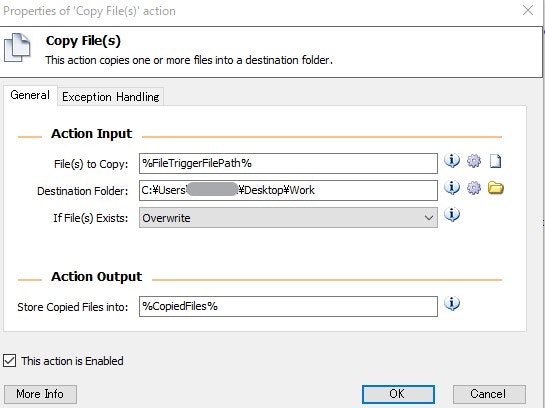

2.Copy File(s)

Dataフォルダに検知したファイルを作業(Work)フォルダにコピー

3.Write Text to File

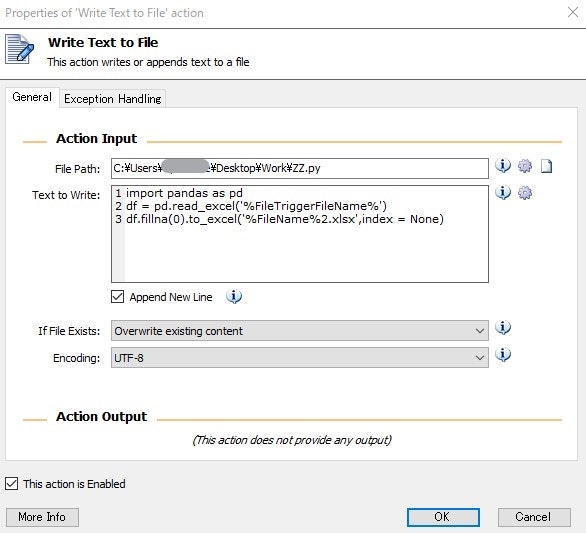

Python Script(.py)の作成

投入するデータファイルが固定されたファイル名であればpython scriptも毎回生成する必要はない

この場合はファイル名に日付が入っているなど変動する場合を想定しているため、毎回ファイル名をTriggerの変数より取得して書き込むようにしている

ZZ.pyという名前を付けてUTF-8で保存

Python ScriptはPandasに読み込んでゼロフィル、ファイル名2.xlsxで保存するだけのショボい内容

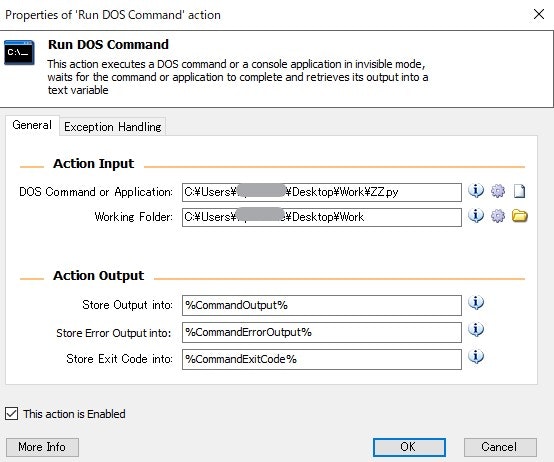

トリガーから作成されると変数部分にファイル名が入るimport pandas as pd df = pd.read_excel('%FileTriggerFileName%') df.fillna(0).to_excel('%FileName%2.xlsx',index = None)4.Run DOS Command

3で作ったZZ.pyファイルを実行

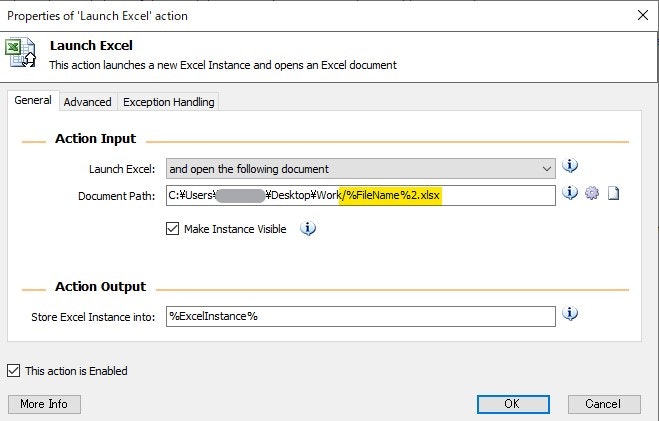

5.Launch Excel

Pythonで生成されたエクセルファイルを開くのだが、変数化したファイル名のパス表記が、変数の手前だけ¥ではなく/とする

はまりポイントなので注意したい

またMake Instance Visibleのチェックを外した場合、画面に表示せず実行できるが、その場合は必ずプロセスの終わりにClose Excelを入れてインスタンスを閉じてあげないと裏で開いたままになるので注意6~17のプロセスについて

これら他システムへの入力の代わりにブランクのExcelに1セルずつデータ部分転記しているだけなので省略する

一括コピーをしないのは他システムで入力するにあたり、トランザクションが発生することを想定しているため

まとめ

ランチャーのpy.exeのおかげで.py Scriptが簡単に実行できます。

WinAutomationのプロセスにPandasなどの便利なライブラリが使えた上で組み込み可能。実をいうとゼロ埋めをするだけならWinAutomationからExcelの置換を使って行うことができます。(一番簡単)

しかし複雑な前処理が必要な場合はExcelの制御は難しいように思います。

WinAutomation単体でも転記する際に空欄ならゼロにするプロセスにすれば同様のことが行えます。

ただしデータを前処理した場合より遅くなります。

筆者のボロマシンCorei7 3770 8Gでは1万行*7列を別Excelに1セルづつ転記した場合前処理ありだと5分50秒

前処理なしでWinAutomationで空欄ならゼロ処理させながら転記した場合は6分30秒でした。WinAutomationの情報はまだ少ないので寂しいなぁ。

- 投稿日:2020-09-13T20:08:48+09:00

Django templates.html を使ってみる

form.pyは、正直全然わかっていないし初めて使います。

ネットで複数記事読みましたが、全然頭に入らず…(笑)でも、とりあえず書いてすすめてみようと思います。

form.pyfrom django import forms from .models import Staff class CreateUserForm(forms.ModelForm): #modelformを継承する class meta(): model = Staff fields = ("name ", "password", "roll", "nyushabi", "taishabi", "hyoujijyun", "jikyu", "delete ")これで、htmlに連携されるってことみたいです。

つづいて、Viewsを作成します。

views.pyfrom django.shortcuts import render from . import CreateUserForm def form_name_view(request): form = forms.UserForm() if request.method == 'POST': form = forms.CreateUserForm(request.POST) if form.is_valid(): form.save() return render(request, 'templates/staff.create.html', {'CreateUserForm': form})if request.method=="POST"

は、初回表示ではないリクエストの時にってことなので、何か入力した後に登録ボタンを押下した時に動作する命令になります。Postでなければ、テンプレートを呼び込んで、FomsからCreateUserForm を呼び込みするイメージです。

本当にこれでいいのかわかっていませんが(笑)次は、テンプレートの作成。

まずは、base.htmlをbootstarpからコピーして一部、改修します。base.html<!doctype html> <html lang="ja"> <head> <!-- Required meta tags --> <meta charset="utf-8"> <meta name="viewport" content="width=device-width, initial-scale=1, shrink-to-fit=no"> <!-- Bootstrap CSS --> <link rel="stylesheet" href="https://stackpath.bootstrapcdn.com/bootstrap/4.5.0/css/bootstrap.min.css" integrity="sha384-9aIt2nRpC12Uk9gS9baDl411NQApFmC26EwAOH8WgZl5MYYxFfc+NcPb1dKGj7Sk" crossorigin="anonymous"> <title> {% block title %} {% endblock title %} </title> </head> <body> {% blcok header %} {% endblock header %} {% block content %} {% endblock content %} <!-- Optional JavaScript --> <!-- jQuery first, then Popper.js, then Bootstrap JS --> <script src="https://code.jquery.com/jquery-3.5.1.slim.min.js" integrity="sha384-DfXdz2htPH0lsSSs5nCTpuj/zy4C+OGpamoFVy38MVBnE+IbbVYUew+OrCXaRkfj" crossorigin="anonymous"></script> <script src="https://cdn.jsdelivr.net/npm/popper.js@1.16.0/dist/umd/popper.min.js" integrity="sha384-Q6E9RHvbIyZFJoft+2mJbHaEWldlvI9IOYy5n3zV9zzTtmI3UksdQRVvoxMfooAo" crossorigin="anonymous"></script> <script src="https://stackpath.bootstrapcdn.com/bootstrap/4.5.0/js/bootstrap.min.js" integrity="sha384-OgVRvuATP1z7JjHLkuOU7Xw704+h835Lr+6QL9UvYjZE3Ipu6Tp75j7Bh/kR0JKI" crossorigin="anonymous"></script> </body> </html>これで、ベースとなる部分の作成完了。

登録用のHTMLは、

staff.create.py{% extends 'staff/base.html' %} {% block content %} {{ form.as_p }} <input type="submit" class="btn btn-primary" value="Submit"> {% block content %}これで、ベースから読み込みしてcontentに差し込みされて表示がされるはず。

最後に、urls.pyを修正

staff.url.pyfrom django.urls import path, include from .views import createstaff urlpatterns = [ path('create/', createstaff, name = "createstaff"), ]これで、サーバーを起動させて一度表示できるか挑戦してみます。

viewsの5行目にある、forms が見つからないってエラーですね。

staff.viewsfrom django.shortcuts import render from .form import CreateUserForm def createstaff(request): form = CreateUserForm.UserForm() if request.method == 'POST': form = forms.CreateUserForm(request.POST) if form.is_valid(): form.save() return render(request, 'templates/staff.create.html', {'CreateUserForm': form})これでリトライしてみる。

まだダメですね。

この後、少しいじって挑戦しましたがエラーが解決できなかったので、formを使うのをやめてclassで作成をしてみるように切替てすすめていこうと思います

- 投稿日:2020-09-13T19:57:23+09:00

tqdmでタスクバー表示

- 投稿日:2020-09-13T19:56:52+09:00

boto3でno attributeのエラーがでたときはバージョンを確認しよう

boto3のエラー

boto3のput_function_event_invoke_configを使用したところ、

import botocore import boto3 client = boto3.client('lambda') response = client.put_function_event_invoke_config( FunctionName=FunctionName, MaximumRetryAttempts=0, )以下のエラーが発生

AttributeError: 'Lambda' object has no attribute 'put_function_event_invoke_config'翻訳すると

AttributeError: 'Lambda' オブジェクトには 'put_function_event_invoke_config' 属性がありません。

とのこと。

lambdaに以下を追記して、boto3とbotocoreのバージョンを確認しました。

print('botocore vertion is {0}'.format(botocore.__version__)) print('boto3 vertion is {0}'.format(boto3.__version__))これが結果

botocore vertion is 1.12.253 boto3 vertion is 1.14.57現在のバージョンを以下で確認したところ・・

Releases · boto/boto3 · GitHub

Releases · boto/botocore · GitHubbotocoreが半年以上古いようです。

botocoreを最新化する

以下の記事の通りで最新化できます。

【AWS】Lambdaでのbotoの使い方と最新botoの使用方法

ServerlessFrameworkの場合は、

serverless-python-requirementsのプラグインを入れてrequirement.txtにboto3とbotocoreを追記することで、最新化できます。以下の記事が参考になります。

【Tips】Serverless Frameworkで最新のboto3をインストールしたLambda Layerをデプロイする解決

botocoreを最新化することで、エラーが解消しました。

参考

- 投稿日:2020-09-13T19:43:48+09:00

一次元と二次元の頂点検出処理

一次元の頂点検出

[-1, 1]で畳み込み処理を行うと上昇している箇所は0を超えた値となり下降している箇所は0未満となる、この事を利用して上昇フラグ、下降フラグを作成、そのフラグが重なりあった箇所を頂点とする。

import math import matplotlib import matplotlib.pyplot as plt import numpy as np import PIL.Image import random import scipy.ndimage # 一次元の頂点検出 x = np.array([0, 0, 1, 0, 0]) print("x", x, "対象配列") conv1 = np.convolve(x, [1, -1], mode="full") print("conv1", conv1, "[-1, 1]のフィルタにより上昇箇所、下降箇所の目印を作る") flag1 = (conv1 > 0).astype(int) print("flag1", flag1, "上昇箇所のフラグ") flag2 = (conv1 <= 0).astype(int) print("flag2", flag2, "下降箇所のフラグ") flag1 = flag1[:-1] print("flag1", flag1, "上昇フラグの末尾を1つ削って長さをあわせる") flag2 = flag2[1:] print("flag2", flag2, "下降フラグの先頭を1つ削って頂点箇所と合わせ、長さも揃える") flag3 = flag1 & flag2 print("flag3", flag3, "上昇フラグと下降フラグを AND した結果が頂点箇所となる")実行結果

x [0 0 1 0 0] 対象配列 conv1 [ 0 0 1 -1 0 0] [-1, 1]のフィルタにより上昇箇所、下降箇所の目印を作る flag1 [0 0 1 0 0 0] 上昇箇所のフラグ flag2 [1 1 0 1 1 1] 下降箇所のフラグ flag1 [0 0 1 0 0] 上昇フラグの末尾を1つ削って長さをあわせる flag2 [1 0 1 1 1] 下降フラグの先頭を1つ削って頂点箇所と合わせ、長さも揃える flag3 [0 0 1 0 0] 上昇フラグと下降フラグを AND した結果が頂点箇所となるサンプルの作成

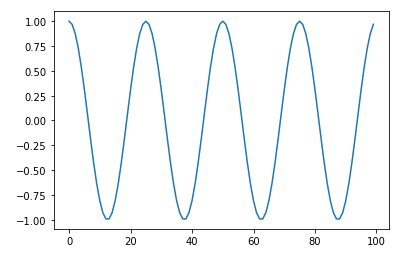

cycle = 4 data = np.zeros(100) cycleWidth = len(data) / cycle unit = math.pi / cycleWidth * 2 for i in range(cycle): for j in range(int(cycleWidth)): data[i * int(cycleWidth) + j] = math.cos(unit * float(j)) plt.plot(data) plt.show()サンプルに対して頂点検出の実行

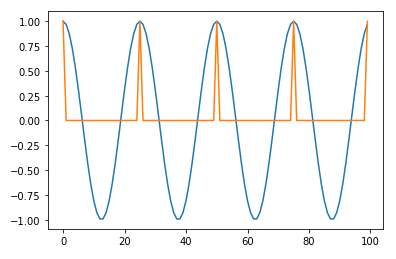

# 一次元の頂点検出を関数化しておく def detectPeak1D(x): conv1 = np.convolve(x, [1, -1], mode="full") flag1 = (conv1 > 0).astype(int) flag2 = (conv1 <= 0).astype(int) flag1 = flag1[:-1] flag2 = flag2[1:] flag3 = flag1 & flag2 return flag3 peaks = detectPeak1D(data) plt.plot(data) plt.plot(peaks) plt.show()水平箇所については立ち上がりが頂点として検出される

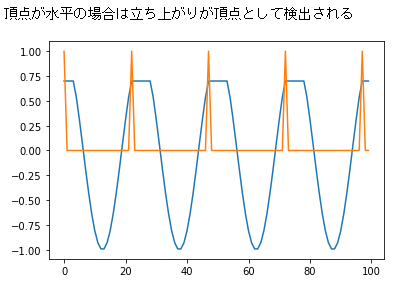

data[data > 0.7] = 0.7 peaks = detectPeak1D(data) print("頂点が水平の場合は立ち上がりが頂点として検出される") plt.plot(data) plt.plot(peaks) plt.show()二次元の頂点検出

一次元の頂点検出を「全ての行に対して行ったフラグ(二次元配列)」と「全ての列に対して行ったフラグ(二次元配列)」の2つをANDした結果を2次元データの頂点とする

# 2次元の頂点検出 x = np.array([ [0, 0, 1, 0, 0], [0, 2, 3, 2, 0], [1, 3, 5, 3, 1], [0, 2, 3, 2, 0], [0, 0, 1, 0, 0], ]) print(x, "対象データ") # すべての行で頂点検出を実行 peaks1 = [] for ix in x: peak = detectPeak1D(ix) peaks1.append(peak) peaks1 = np.array(peaks1) print(peaks1, "横方向の頂点検出フラグ") # すべての列で頂点検出を実行 peaks2 = [] for ix in x.transpose(): peak = detectPeak1D(ix) peaks2.append(peak) peaks2 = np.array(peaks2).transpose() # transposeにより検出を実行したのでもとに戻す print(peaks2, "縦方向の頂点検出フラグ") peaks3 = (peaks1 & peaks2).astype(int) print(peaks3, "行、列の検出フラグをANDして残ったフラグが2次元の頂点フラグとなる")実行結果

[[0 0 1 0 0] [0 2 3 2 0] [1 3 5 3 1] [0 2 3 2 0] [0 0 1 0 0]] 対象データ [[0 0 1 0 0] [0 0 1 0 0] [0 0 1 0 0] [0 0 1 0 0] [0 0 1 0 0]] 横方向の頂点検出フラグ [[0 0 0 0 0] [0 0 0 0 0] [1 1 1 1 1] [0 0 0 0 0] [0 0 0 0 0]] 縦方向の頂点検出フラグ [[0 0 0 0 0] [0 0 0 0 0] [0 0 1 0 0] [0 0 0 0 0] [0 0 0 0 0]] 行、列の検出フラグをANDして残ったフラグが2次元の頂点フラグとなる# 二次元の頂点検出を関数化しておく def detectPeak2D(x): peaks1 = [] for ix in x: peak = detectPeak1D(ix) peaks1.append(peak) peaks1 = np.array(peaks1) peaks2 = [] for ix in x.transpose(): peak = detectPeak1D(ix) peaks2.append(peak) peaks2 = np.array(peaks2).transpose() flag = (peaks1 & peaks2).astype(int) return flag二次元データサンプルの作成

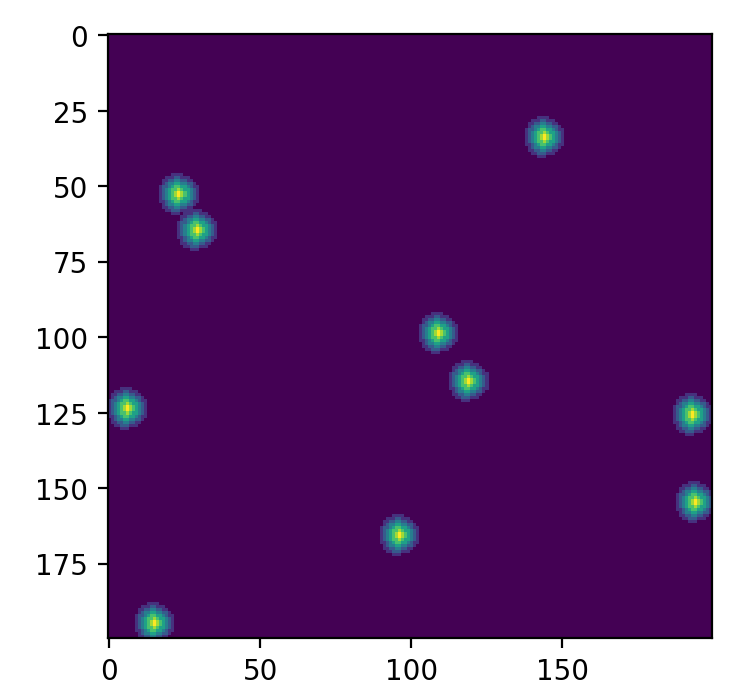

# 二次元頂点検出の試験用データを作成する、一次元の頂点のあるデータを回転させて作る random.seed(1) data2d = np.zeros((200, 200)) pattern = np.array([1, 2, 3, 4, 5, 6, 7, 6, 5, 4, 3, 2, 1]) for i in range(10): ox, oy = random.randrange(200), random.randrange(200) for j in range(50): rad = (math.pi / 50) * j for ix, v in enumerate(pattern): pos = ix - len(pattern) / 2 x = ox + math.cos(rad) * pos y = oy + math.sin(rad) * pos if x < 0: continue if x >= 200: continue if y < 0: continue if y >= 200: continue data2d[int(x)][int(y)] = v plt.figure(figsize=(10,4),dpi=200) plt.imshow(data2d) plt.show()二次元サンプル画像

二次元頂点検出の実行

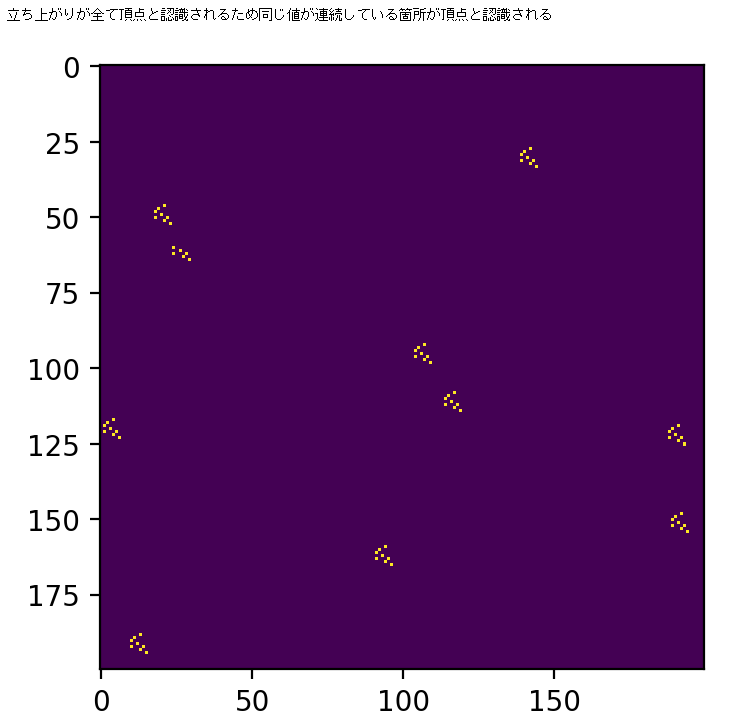

peaks = detectPeak2D(data2d) print("立ち上がりが全て頂点と認識されるため同じ値が連続している箇所が頂点と認識される") plt.figure(figsize=(10,4),dpi=200) plt.imshow(peaks) plt.show()平滑化処理を施してから二次元頂点検出の実行

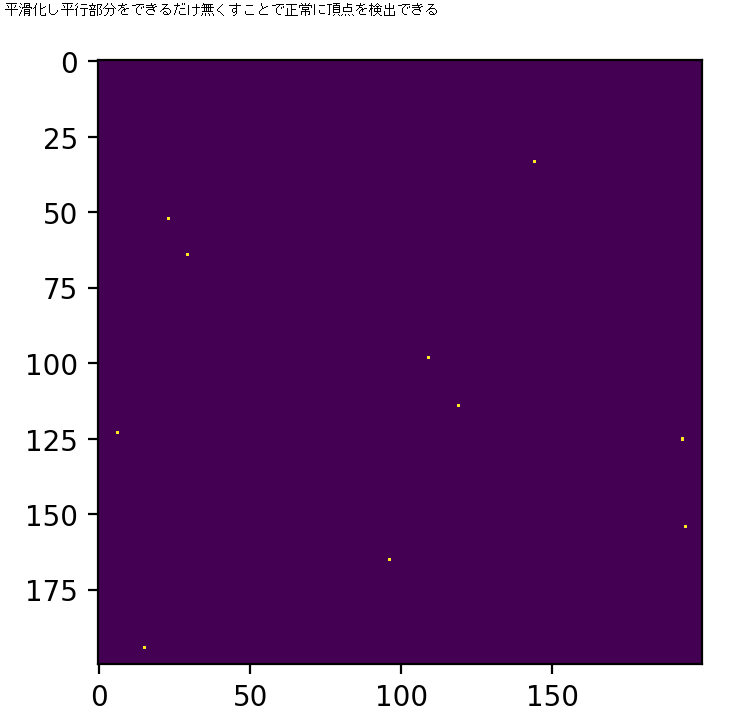

data2dGaussian = scipy.ndimage.gaussian_filter(data2d, sigma=1) peaks = detectPeak2D(data2dGaussian) print("平滑化し平行部分をできるだけ無くすことで正常に頂点を検出できる") plt.figure(figsize=(10,4),dpi=200) plt.imshow(peaks) plt.show()注意等

前処理も加工処理もなくキレイに山なりの形をしているデータを想定した処理です、基本的には平滑化してからでないと想定通りの動作をしない事が多いと思います、そのまま使うのではなく移動平均でもガウシアンフィルタでもなんでも良いので平滑化処理を行ってから使用します。

以上です。

- 投稿日:2020-09-13T19:02:38+09:00

Google Colaboratoryで書籍「Pythonで儲かるAIをつくる」の実習コードを動かす方法

はじめに

書籍「Pythonで儲かるAIをつくる」の著者です。

Amazonリンク

https://www.amazon.co.jp/dp/4296106961/この本では、書籍サポートサイトに実習コードをすべて公開しています。

https://github.com/makaishi2/profitable_ai_book_info/blob/master/README.mdこれらのコードは導入なしに利用できるクラウド環境Google Colaboratoryで動かすことを前提にしています。

書籍購入を検討中の方が、実習コードを試しに動かすことの参考となるよう、Google Colaboratoryでこの本の実習コードを動かすための手順を、当記事で説明します。事前準備

必要な事前準備は、gmailアカウントの取得と、Chromeブラウザの導入の2つです。

gmail アカウント

gmailアカウント取得に関しては、いろいろなところでガイドが出ているので、説明を省略します。

Chrome導入

Colaboratoryを動かす場合の推奨ブラウザは、Google Chromeです。

まだ、自分のパソコンに導入していない場合は、以下のリンクから、ダウンロード・導入を済ませて下さい。https://www.google.co.jp/chrome/

Chromeでgmailにログイン

上の2つの準備が終わったら、Chromeを立ち上げて、gmailにログインした状態にします。これで、すべての準備は完了しました。

Colaboratory起動

Colaboratory立ち上げ

新しいタブを開いて、以下のURLを入力して下さい。

https://colab.research.google.com/

下のような画面が出てくるので、Githubのタブを選択します。

下の画面が出てきたら

① 一番上の欄にhttps://github.com/makaishi2と入力し、Enterキーを押します。② その下の欄がdropdownに変化するので、クリックして

profitable_ai_book_infoを選択します。下の画面になるので、読み込みたいファイルを選択します。

ファイル名と、中身の対応については、次のリンクを参考にして下さい。

https://github.com/makaishi2/profitable_ai_book_info/blob/master/refs/notebooks.md例えば、3章の実習を選択したい場合、下の図のように

ch03_03_first_ml.ipynbを選びます。下の図のようになっていれば、Notebookの読み込みに成功しています。

最低限の使い方として、この状態で、Shift + Enterをひたすら繰り返すと、セルと呼ばれる処理の単位を一つずつ順に実行することが可能です。下のワーニングが出る場合は、右の「このまま実行」を選んで下さい。

最後までうまく実行できると、こんな画面になるはずです。

- 投稿日:2020-09-13T18:49:23+09:00

【Python】Slackbotでパスワードを生成する

こんにちは、みやびのです。

今回はSlackbot+Pythonでパスワードを実装する方法について説明します。

具体的には以下の2つについて説明します。・Pythonでパスワードを生成する方法

・Slackbot+Pythonでパスワードを生成するPythonで作るSlackbotの基本については「SlackbotをPythonで作成しよう」をお読みください。

Pythonでパスワード生成する方法

Pythonのrandomライブラリを活用すれば比較的簡単にパスワード生成処理を作成できます。

関数実装例引数1:パスワードの桁数(デフォルト8) 引数2:文字列の種類(デフォルト:大文字・小文字・数字) リターン値:パスワード引数1に指定した桁数分の文字列をリターン。

さらに引数2によって「小文字と数字」、「大文字と小文字」、「大文字だけ」のように文字列を細かく指定できるようにします。import random def make_password(digit=8, word_type=None): words = '' password = '' uppercase = 'ABCDEFGHIJKLMNOPQRSTUVWXYZ' lowercase = 'abcdefghijklmnopqrstuvwxyz' number = '0123456789' # 引数がない場合は全て指定 if word_type is None: word_type = ['uppercase', 'lowercase', 'number'] # 使用する文字の判定 if 'uppercase' in word_type: words = words + uppercase if 'lowercase' in word_type: words = words + lowercase if 'number' in word_type: words = words + number # パスワードを生成ループ for i in range(0, digit): # 配列で返ってくるので0番目の値を取得 password = password + random.sample(words, 1)[0] return passwordパスワードの実装方法の詳細については「Pythonでパスワード生成処理を実装する」をお読みください。

Slackbot+Pythonでパスワードを生成する

上記処理をSlackbotの応答に埋め込みます。

Slackbotの応答仕様

引数1:パスワードの桁数

引数2:パスワードの文字の種類文字の種類は以下の形で指定します。

数字:数字のみ 大英数字:大文字の英字と数字 小英数字:小文字の英字と数字 英字:小文字と大文字の英字 大英字:大文字の英字のみ 小英字:小文字の英字のみ それ以外:英数字全てパスワードをダイレクトメッセージに送信

message.send()でチャンネルに応答してしまうと他の人にもパスワードが見えてしまうためセキュリティ上あまりよろしくありません。

よってダイレクトメッセージに応答します。ダイレクトメッセージへの応答はslackerライブラリを使用すれば実現できます。

ダイレクトメッセージを使う場合はチャンネル名の代わりにユーザIDの指定が必要です。

ユーザIDはmessageに格納されています。

```pyユーザーID取得

user_id = message.user['id']

ダイレクトメッセージでパスワードを送信

slack = Slacker(slackbot_settings.API_TOKEN)

slack.chat.post_message(user_id, password, as_user=True)

```実装例は以下の通り。

import random from slackbot.bot import respond_to from slacker import Slacker import slackbot_settings def make_password(digit=8, word_type=None): words = '' password = '' uppercase = 'ABCDEFGHIJKLMNOPQRSTUVWXYZ' lowercase = 'abcdefghijklmnopqrstuvwxyz' number = '0123456789' # 引数がない場合は全て指定 if word_type is None: word_type = ['uppercase', 'lowercase', 'number'] # 使用する文字の判定 if 'uppercase' in word_type: words = words + uppercase if 'lowercase' in word_type: words = words + lowercase if 'number' in word_type: words = words + number # パスワードを生成ループ for i in range(0, digit): # 配列で返ってくるので0番目の値を取得 password = password + random.sample(words, 1)[0] return password @respond_to('^パスワード生成s(.*)s(.*)$') def response_pass(message, digit, param_type): # ユーザーID取得 user_id = message.user['id'] # パターンの切り分け if param_type == '数字': word_type = ['number'] elif param_type == '大英数字': word_type = ['lowercase', 'number'] elif param_type == '小英数字': word_type = ['lowercase', 'number'] elif param_type == '英字': word_type = ['lowercase', 'uppercase'] elif param_type == '大英字': word_type = ['uppercase'] elif param_type == '小英字': word_type = ['lowercase'] else: word_type = ['uppercase', 'lowercase', 'number'] # パスワード生成 password = make_password(int(digit), word_type) # ダイレクトメッセージでパスワードを送信 slack = Slacker(slackbot_settings.API_TOKEN) slack.chat.post_message(user_id, password, as_user=True) message.send('パスワードをダイレクトメッセージに送信しました!')パスワードはダイレクトメッセージの方に送信されています。

終わりに

今回紹介したように比較的簡単にSlackbotをパスワード生成ツールにすることができます。

ちょっとしたパスワードを作りたい場合にあると便利ですね。パスワード生成サイトなどもありますが、自由にカスタマイズできるのが人の作った生成サイトにはないメリットです。

今回は英数字1パターンの表示のみでしたが複数パターンの表示をしたり、記号も使えるようにしたりなどいろいろカスタマイズしてみてください。Slackbotの活用方法はブログでもまとめています。

Slackbotの作り方マニュアル〜Python編〜

- 投稿日:2020-09-13T18:40:32+09:00

Pythonの数値計算ライブラリ「Numpy」の配列(ndarray)操作一覧

Pythonの数値計算ライブラリ「Numpy」が提供するN次元配列オブジェクト(以下、ndarray)の操作方法を整理する。

Pythonはデータ型のサポートがない為に計算が低速であり、大量のデータを使って計算する際にはndarrayを使う事が標準的です。前提

import numpy as npA. 配列生成

ndarrayを生成する。

【

array(object, dtype=None, copy=True, order='K', subok=False, ndmin=0)】

- リストからndarrayを作成する。

- object:元となるリスト(又はそのように扱う事ができるもの)

- dtype:要素のデータ型。未指定の場合は要素に基づいて自動選択。(参考:NumPyのデータ型dtype一覧とastypeによる変換(キャスト) | note.nkmk.me)

y = np.array([1,2,3]) X = np.array([[1,2,3], [4,5,6]], dtype=np.int64)【

zeros(shape, dtype=float, order='C')】

- 各要素が0で埋められたndarrayを生成する。

- shape:各次元の要素数(整数又は整数のタプル)

y = np.zeros(3) # array([0., 0., 0.]) X = np.zeros((2,3)) # array([[0., 0., 0.], # [0., 0., 0.]])【

ones(shape, dtype=None, order='C')】

- 各要素が1で埋めれらたndarrayを生成する。

y = np.ones(3) # array([1., 1., 1.]) X = np.ones((2,3)) # array([[1., 1., 1.], # [1., 1., 1.]])【

empty(shape, dtype=None, order='C')】

- 各要素が初期化されていないndarrayを生成する。

y = np.empty(3) # array([0.39215686, 0.70980392, 0.80392157]) X = np.empty((2,3)) # array([[2.6885677e-316, 0.0000000e+000, 0.0000000e+000], # [0.0000000e+000, 0.0000000e+000, 0.0000000e+000]])【

identity(n, dtype=None)】

- 単位行列となるndarrayを生成する。

X = np.identity(3) # array([[1., 0., 0.], # [0., 1., 0.], # [0., 0., 1.]])【

arange([start,] stop[, step,], dtype=None)】

- 等差数列となるndarrayを生成する。

- start:等差数列の開始値

- stop:等差数列の終了の基準値(指定した値以上の値は数列に含まれない)

- step:差

y = np.arange(5) # array([0, 1, 2, 3, 4]) y = np.arange(2,5) # array([2, 3, 4]) y = np.arange(5,2,-1) # array([5, 4, 3])【

linspace(start, stop, num=50, endpoint=True, retstep=False, dtype=None)】

- 指定範囲を分割した等差数列となるndarrayを生成する。

- start:等差数列の開始値

- stop:等差数列の終了値

- step:分割値(配列の要素数)

y = np.linspace(2,10,3) # array([ 2., 6., 10.]) y = np.linspace(2,10,5) # array([ 2., 4., 6., 8., 10.])【

unique(ar, return_index=False, return_inverse=False, return_counts=False, axis=None)】

- ソートした上で重複を削除したndarrayを生成する。

y = np.unique(['C', 'E', 'C', 'A', 'B', 'E', 'D', 'C']) # array(['A', 'B', 'C', 'D', 'E'], dtype='<U1')B. 配列要素取得

ndarrayの要素は、Pythonでのリスト要素の取得と同じ方法で取得できる。

ただし、多次元配列の場合は指定方法が変わるので注意する。X = [[1,2,3],[4,5,6]] print(X[1][2]) # 6 X_numpy = np.array(X) print(X_numpy[1,2]) # 6又、通常の取得方法とは別に次の方法でも取得できる。

1. インデックスの配列で取得する。

X = np.array([[1,2,3],[4,5,6]]) print(X[[0,1,-1]]) # [[1 2 3], # [4 5 6], # [4 5 6]] print(X[[0,1,-1], 0]) # [1, 4, 4] print(X[[0,1,-1], ::-1]) # [[3 2 1], # [6 5 4], # [6 5 4]] print(X[[0,1,-1],[1,0,-1]]) # [2, 4, 6] """ ※この指定は、次と同じ結果になっている。 np.array([X[0,1], X[1,0], X[-1,-1]]) """2. 条件式で取得する。

X = np.array([[1,2,3],[4,5,6]]) print(X > 4) # [[False, False, False], # [False, True, True]] print(np.where(X > 4)) # (array([1, 1]), array([1, 2])) print(X[X > 4]) # [5, 6] print(X[np.where(X > 4)]) # [5, 6]C. 配列情報の取得

ndarrayの情報を取得する。

【

shape】

- 各次元の要素数を取得する。

X = np.array([[1,2,3], [4,5,6]]) X.shape # (2, 3)【

dtype】

- データ型を取得する。

X = np.array([[1,2,3], [4,5,6]]) X.dtype # dtype('int64')【

ndim】

- 次元数を取得する。

X = np.array([[1,2,3], [4,5,6]]) X.ndim # 2【

size】

- 要素数を取得する。

X = np.array([[1,2,3], [4,5,6]]) X.size # 6D. 配列操作

ndarrayを操作する。

【

<ndarray>.flatten(order='C')】

- 一次元配列にする。

X = np.array([[1,2,3], [4,5,6]]) print(X.flatten()) # [1, 2, 3, 4, 5, 6]【

<ndarray>.reshape(shape, order='C')】

- 配列の形状(次元数および各次元の要素数)を変える。

X = np.array([1,2,3,4,5,6]) print(X.reshape((3,2))) # [[1, 2], # [3, 4], # [5, 6]]【

sort(a, axis=-1, kind='quicksort', order=None)】

- 並び替える。(対象をコピーし、コピーを並べ替えて返す)

- axis:ソートする次元

X1 = np.array([[5,4,6], [3,1,2]]) X2 = np.sort(X1) print(X1) # [[5 4 6] # [3 1 2]] print(X2) # [[4 5 6] # [1 2 3]] X3 = np.sort(X1, axis=0) print(X3) # [[3 1 2] # [5 4 6]]【

<ndarray>.sort(axis=-1, kind='quicksort', order=None)】

- 並び替える。(対象を並び替える)

- axis:ソートする次元

X = np.array([[5,4,6], [3,1,2]]) X.sort() print(X) # [4 5 6] # [1 2 3]] X.sort(axis=0) print(X) # [[3 1 2] # [5 4 6]]【

<ndarray>.argsort(axis=-1, kind='quicksort', order=None)】

- 並び替えた時のインデックスを取得する。

X = np.array([[5,4,6], [3,1,2]]) idxs = X.argsort() print(idxs) # [[1 0 2] # [1 2 0]] idxs = X.argsort(axis=0) print(idxs) # [[1 1 1] # [0 0 0]]【

<ndarray>.astype(dtype, order='K', casting='unsafe', subok=True, copy=True)】

- ndarrayのデータ型を変換する。

X = np.array([[1,2,3], [4,5,6]]) print(X.dtype) # int64 print(X) # [[1 2 3] # [4 5 6]] X2 = X.astype(np.float64) print(X2.dtype) # float64 print(X2) # [[1. 2. 3.] # [4. 5. 6.]]E. 行列操作

ndarrayで行列操作を行う。

【

<ndarray>.T】

- 転置

X = np.array([[1,2,3], [4,5,6]]) print(X.T) # [[1, 4], # [2, 5], # [3, 6]]【

numpy.dot】【<ndarray>.dot】

- 内積

X1 = np.array([[1, 2, 3], [4, 5, 6]]) X2 = np.array([[10, 20], [100, 200], [1000, 2000]]) print(np.dot(X1, X2)) # [[ 3210 6420] # [ 6540 13080]] print(X1.dot(X2)) # [[ 3210 6420] # [ 6540 13080]]【

numpy.trace】【<ndarray>.trace】

- 対角成分の合計

X = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]]) print(np.trace(X)) # 15 print(X.trace()) # 15【

numpy.linalg.det】

- 行列式

X1 = np.array([[3., 2.], [5., 4.]]) print(np.linalg.det(X1)) # 2.0000000000000013【

numpy.linalg.eig】

- 固有値・固有ベクトル

X = np.array([[2, 0], [0, 0.25]]) print(np.linalg.eig(X)) # (array([2. , 0.25]), array([[1., 0.], [0., 1.]]))【

numpy.linalg.svd】

- 特異値分解

X = np.array([[2, 0], [0, 0.25], [0, 1]]) print(np.linalg.svd(X)) # (array([[ 1., 0. , 0. ], # [ 0., -0.24253563, -0.9701425 ], # [ 0., -0.9701425 , 0.24253563]]), # array([2., 1.03077641]), # array([[ 1., 0.], # [-0., -1.]]))【

numpy.linalg.inv】

- 逆行列

X = np.array([[1, 1], [1, -1]]) print(np.linalg.inv(X)) # [[ 0.5 0.5] # [ 0.5 -0.5]]【

numpy.linalg.pinv】

- ムーア・ペンローズの擬似逆行列

X = np.array([[1, 1], [1, -1], [1, 0]]) print(np.linalg.pinv(X)) # [[ 0.33333333 0.33333333 0.33333333] # [ 0.5 -0.5 0. ]]【

numpy.linalg.qr】

- QR分解

X = np.array([[1, 2], [3, 4], [5, 6]]) print(np.linalg.qr(X)) # (array([[-0.16903085, 0.89708523], # [-0.50709255, 0.27602622], # [-0.84515425, -0.34503278]]), # array([[-5.91607978, -7.43735744], # [ 0. , 0.82807867]]))F. 算術演算

二つのndarray同士で、算術演算をする。

【

add】

- 足し算(加算)

a = np.array([[1, 2, 3], [4, 5, 6]]) print(np.add(a, 10)) # [[11 12 13] # [14 15 16]] print(a + 10) # [[11 12 13] # [14 15 16]] print(np.add(a, [10, 20, 30])) # [[11 22 33] # [14 25 36]] print(a + [10, 20, 30]) # [[11 22 33] # [14 25 36]] print(np.add(a, np.array([[10, 20, 30], [40, 50, 60]]))) # [[11 22 33] # [44 55 66]] print(a + np.array([[10, 20, 30], [40, 50, 60]])) # [[11 22 33] # [44 55 66]]【

subtract】

- 引き算(減算)

a = np.array([[11, 22, 33], [44, 55, 66]]) print(np.subtract(a, 10)) # [[ 1 12 23] # [34 45 56]] print(a - 10) # [[ 1 12 23] # [34 45 56]] print(np.subtract(a, [10, 20, 30])) # [[ 1 2 3] # [34 35 36]] print(a - [10, 20, 30]) # [[ 1 2 3] # [34 35 36]] print(np.subtract(a, np.array([[10, 20, 30], [40, 50, 60]]))) # [[1 2 3] # [4 5 6]] print(a - np.array([[10, 20, 30], [40, 50, 60]])) # [[1 2 3] # [4 5 6]]【

multiply】

- 掛け算(乗算)

a = np.array([[1, 2, 3], [4, 5, 6]]) print(np.multiply(a, 10)) # [[10 20 30] # [40 50 60]] print(a * 10) # [[10 20 30] # [40 50 60]] print(np.multiply(a, [10, 20, 30])) # [[ 10 40 90] # [ 40 100 180]] print(a * [10, 20, 30]) # [[ 10 40 90] # [ 40 100 180]] print(np.multiply(a, np.array([[10, 20, 30], [40, 50, 60]]))) # [[ 10 40 90] # [160 250 360]] print(a * np.array([[10, 20, 30], [40, 50, 60]])) # [[ 10 40 90] # [160 250 360]]【

divide】

- 割り算(除算)

a = np.array([[10, 20, 30], [40, 50, 60]]) print(np.divide(a, 10)) # [[1. 2. 3.] # [4. 5. 6.]] print(a / 10) # [[1. 2. 3.] # [4. 5. 6.]] print(np.divide(a, [10, 20, 30])) # [[1. 1. 1. ] # [4. 2.5 2. ]] print(a / [10, 20, 30]) # [[1. 1. 1. ] # [4. 2.5 2. ]] print(np.divide(a, np.array([[10, 20, 30], [40, 50, 60]]))) # [[1. 1. 1.] # [1. 1. 1.]] print(a / np.array([[10, 20, 30], [40, 50, 60]])) # [[1. 1. 1.] # [1. 1. 1.]]【

floor_divide】

- 割り算の商

a = np.array([[22, 33, 44], [45, 67, 89]]) print(np.floor_divide(a, 2)) # [[11 16 22] # [22 33 44]] print(a // 2) # [[11 16 22] # [22 33 44]] print(np.floor_divide(a, [2, 3, 4])) # [[11 11 11] # [22 22 22]] print(a // [2, 3, 4]) # [[11 11 11] # [22 22 22]] print(np.floor_divide(a, np.array([[2, 3, 4], [4, 6, 8]]))) # [[11 11 11] # [11 11 11]] print(a // np.array([[[2, 3, 4], [4, 6, 8]]])) # [[11 11 11] # [11 11 11]]【

mod】

- 割り算の余り

a = np.array([[22, 33, 44], [45, 67, 89]]) print(np.mod(a, 2)) # [[0 1 0] # [1 1 1]] print(a % 2) # [[0 1 0] # [1 1 1]] print(np.mod(a, [2, 3, 4])) # [[0 0 0] # [1 1 1]] print(a % [2, 3, 4]) # [[0 0 0] # [1 1 1]] print(np.mod(a, np.array([[2, 3, 4], [4, 6, 8]]))) # [[0 0 0] # [1 1 1]] print(a % np.array([[[2, 3, 4], [4, 6, 8]]])) # [[0 0 0] # [1 1 1]]【

power】

- 累乗

a = np.array([[1, 2, 3], [4, 5, 6]]) print(np.power(a, 2)) # [[ 1 4 9] # [16 25 36]] print(a ** 2) # [[ 1 4 9] # [16 25 36]] print(np.power(a, [2, 3, 4])) # [[ 1 8 81] # [ 16 125 1296]] print(a ** [2, 3, 4]) # [[ 1 8 81] # [ 16 125 1296]] print(np.power(a, np.array([[2, 3, 4], [1/2, 1/3, 1/4]]))) # [[ 1. 8. 81. ] # [ 2. 1.70997595 1.56508458]] print(a ** np.array([[2, 3, 4], [1/2, 1/3, 1/4]])) # [[ 1. 8. 81. ] # [ 2. 1.70997595 1.56508458]]G. 比較演算

二つのndarrayを比較する。

【

greater】

- より大きい

a1 = np.array([10, 10, 10, 10, 10]) a2 = np.array([9, 9.9, 10, 10.1, 11]) print(np.greater(a1, a2)) # [ True True False False False] print(a1 > a2) # [ True True False False False]【

greater_equal】

- 以上

a1 = np.array([10, 10, 10, 10, 10]) a2 = np.array([9, 9.9, 10, 10.1, 11]) print(np.greater_equal(a1, a2)) # [ True True True False False] print(a1 >= a2) # [ True True True False False]【

less】

- より小さい

a1 = np.array([10, 10, 10, 10, 10]) a2 = np.array([9, 9.9, 10, 10.1, 11]) print(np.less(a1, a2)) # [False False False True True] print(a1 < a2) # [False False False True True]【

less_equal】

- 以下

a1 = np.array([10, 10, 10, 10, 10]) a2 = np.array([9, 9.9, 10, 10.1, 11]) print(np.less_equal(a1, a2)) # [False False True True True] print(a1 <= a2) # [False False True True True]【

equal】

- 等しい

a1 = np.array([10, 10, 10, 10, 10]) a2 = np.array([9, 9.9, 10, 10.1, 11]) print(np.equal(a1, a2)) # [False False True False False] print(a1 == a2) # [False False True False False]【

not_equal】

- 等しくない

a1 = np.array([10, 10, 10, 10, 10]) a2 = np.array([9, 9.9, 10, 10.1, 11]) print(np.not_equal(a1, a2)) # [ True True False True True] print(a1 != a2) # [ True True False True True]H. 論理演算

二つのndarrayを論理演算する。

【

logical_and】

- AND

a1 = np.array([True, False, True, False]) a2 = np.array([True, False, False, True]) print(np.logical_and(a1, a2)) # [ True False False False]【

logical_or】

- OR

a1 = np.array([True, False, True, False]) a2 = np.array([True, False, False, True]) print(np.logical_or(a1, a2)) # [ True False True True]【

logical_xor】

- XOR

a1 = np.array([True, False, True, False]) a2 = np.array([True, False, False, True]) print(np.logical_xor(a1, a2)) # [False False True True]【

logical_not】

- NOT

a = np.array([True, False, True, False]) print(np.logical_not(a)) # [False True False True]【

<ndarray>.any()】

- いずれかの要素がTrue

a1 = np.array([0, 1, 0, 0]) print(a1.any()) # True a2 = np.array([1, 1, 1, 1]) print(a2.any()) # True a3 = np.array([0, 0, 0, 0]) print(a3.any()) # False【

<ndarray>.all()】

- すべての要素がTrue

a1 = np.array([0, 1, 0, 0]) print(a1.all()) # False a2 = np.array([1, 1, 1, 1]) print(a2.all()) # True a3 = np.array([0, 0, 0, 0]) print(a3.all()) # FalseI. 集合演算

ndarrayでの集合演算をする。

※集合演算自体はPythonのsetでも行える。参考:Pythonの集合演算【

union1d(ar1, ar2)】

- 和集合(OR)

X = np.unique([1,2,3,4,5,6]) Y = np.unique([4,5,6,7,8,9]) Z = np.union1d(X,Y) print(Z) # [1 2 3 4 5 6 7 8 9]【

intersect1d(ar1, ar2)】

- 積集合(AND)

X = np.unique([1,2,3,4,5,6]) Y = np.unique([4,5,6,7,8,9]) Z = np.intersect1d(X,Y) print(Z) # [4 5 6]【

setxor1d(ar1, ar2)】

- 対称差(XOR)

X = np.unique([1,2,3,4,5,6]) Y = np.unique([4,5,6,7,8,9]) Z = np.setxor1d(X,Y) print(Z) # [1 2 3 7 8 9]【

setdiff1d(ar1, ar2)】

- 差集合

X = np.unique([1,2,3,4,5,6]) Y = np.unique([4,5,6,7,8,9]) Z = np.setdiff1d(X,Y) print(Z) # [1 2 3]【

in1d(ar1, ar2)】

- 前者の集合の各要素が後者に含まれるかの判定

X = np.unique([1,2,3,4,5]) Y = np.unique([1,2,3]) Z = np.in1d(X,Y) print(Z) # [ True True True False False]J. 最大値・最小値・符号抽出

ndarrayの最大値・最小値・符号を抽出する。

【

maximum】

- 最大値(2つのndarrayを比較し、大きい方を取得)

- 片方の要素がNaNの場合は、NaNを取得。

a1 = np.array([4, 2, np.nan]) a2 = np.array([3, 6, 5]) print(np.maximum(a1, a2)) # [ 4. 6. nan]【

fmax】

- 最大値(2つのndarrayを比較し、大きい方を取得)

- 片方の要素がNaNの場合は、もう片方を取得。

a1 = np.array([4, 2, np.nan]) a2 = np.array([3, 6, 5]) print(np.fmax(a1, a2)) # [4. 6. 5.]【

minimum】

- 最小値(2つのndarrayを比較し、小さい方を取得)

- 片方の要素がNaNの場合は、NaNを取得。

a1 = np.array([4, 2, np.nan]) a2 = np.array([3, 6, 5]) print(np.minimum(a1, a2)) # [ 3. 2. nan]【

fmin】

- 最小値(2つのndarrayを比較し、小さい方を取得)

- 片方の要素がNaNの場合は、もう片方を取得。

a1 = np.array([4, 2, np.nan]) a2 = np.array([3, 6, 5]) print(np.fmin(a1, a2)) # [3. 2. 5.]【

copysign】

- 1つ目のndarrayに、2つ目のndarrayで対応する要素の符号を当てる。

a1 = np.array([1, 2, 3, 4, 5]) a2 = np.array([0, -1, 1, 2, -2]) print(np.copysign(a1, a2)) # [ 1. -2. 3. 4. -5.]K. 切り上げ・切り捨て・四捨五入

ndarrayの各値で、小数点以下の値を処理する。

【

ceil(ndarray)】

- 切り上げ

y = np.array([-5.6, -5.5, -5.4, 0, 5.4, 5.5, 5.6]) z = np.ceil(y) print(z) # [-5. -5. -5. 0. 6. 6. 6.]【

floor(ndarray)】

- 切り捨て

y = np.array([-5.6, -5.5, -5.4, 0, 5.4, 5.5, 5.6]) z = np.floor(y) print(z) # [-6. -6. -6. 0. 5. 5. 5.]【

rint(ndarray)】

- 四捨五入

y = np.array([-5.6, -5.5, -5.4, 0, 5.4, 5.5, 5.6]) z = np.rint(y) print(z) # [-6. -6. -5. 0. 5. 6. 6.]【

modf(ndarray)】

- 整数部と小数部の分割

y = np.array([-3.6, -2.5, -1.4, 0, 1.4, 2.5, 3.6]) z = np.modf(y) print(z) # (array([-0.6, -0.5, -0.4, 0. , 0.4, 0.5, 0.6]), array([-3., -2., -1., 0., 1., 2., 3.]))L. 二乗・平方根・絶対値

ndarrayの各値で、二乗・平方根・絶対値を算出する。

【

square(ndarray)】

- 二乗

y = np.arange(1,6) z = np.square(y) print(z) # [ 1 4 9 16 25] z = y ** 2 print(z) # [ 1 4 9 16 25]【

sqrt(ndarray)】

- 平方根

y = np.array([1,4,9,16,25]) z = np.sqrt(y) print(z) # [1. 2. 3. 4. 5.] z = y ** 0.5 print(z) # [1. 2. 3. 4. 5.]【

abs(ndarray)】

- 絶対値

y = np.array([-1,-2,3,4,5j]) z = np.abs(y) print(z) # [1, 2, 3, 4, 5]【

fabs(ndarray)】

- 絶対値(虚数・複素数不可だが、absより高速)

y = np.array([-1,-2,3,4,-5]) z = np.fabs(y) print(z) # [1, 2, 3, 4, 5]M. 指数・対数関数

ndarrayの各値で、指数・対数を算出する。

【

exp(ndarray)】

- 指数

y = np.arange(1,6) z = np.exp(y) print(z) # [ 2.71828183 7.3890561 20.08553692 54.59815003 148.4131591 ] print(np.e) # 2.718281828459045【

log(ndarray)】

- 自然対数

y = np.e ** np.array([1, 2, 3, 4, 5]) z = np.log(y) print(z) # [1. 2. 3. 4. 5.]【

log10(ndarray)】

- 常用対数

y = 10 ** np.array([1, 2, 3, 4, 5]) z = np.log10(y) print(z) # [1. 2. 3. 4. 5.]【

log2(ndarray)】

- 二進対数

y = 2 ** np.array([1, 2, 3, 4, 5]) z = np.log2(y) print(z) # [1. 2. 3. 4. 5.]N. 三角関数

ndarrayの各値に、三角関数を適用する。

【

sin(ndarray)】

- 正弦

y = np.linspace(-1, 1, 5) * np.pi print(np.sin(y)) # [-1.2246468e-16 -1.0000000e+00 0.0000000e+00 1.0000000e+00 1.2246468e-16]【

cos(ndarray)】

- 余弦

y = np.linspace(-1, 1, 5) * np.pi print(np.cos(y)) # [-1.000000e+00 6.123234e-17 1.000000e+00 6.123234e-17 -1.000000e+00]【

tan(ndarray)】

- 正接

y = np.linspace(-1, 1, 5) * np.pi print(np.tan(y)) # [ 1.22464680e-16 -1.63312394e+16 0.00000000e+00 1.63312394e+16 -1.22464680e-16]O. 双曲線関数

ndarrayの各値に、双曲線関数を適用する。

【

sinh(ndarray)】

- 双曲線正弦

y = np.array([-np.inf, -2, -1, 0, 1, 2, np.inf]) print(np.sinh(y)) # [-inf -3.62686041 -1.17520119 0. 1.17520119 3.62686041 inf]【

cosh(ndarray)】

- 双曲線余弦

y = np.array([-np.inf, -2, -1, 0, 1, 2, np.inf]) print(np.cosh(y)) # [inf 3.76219569 1.54308063 1. 1.54308063 3.76219569 inf]【

tanh(ndarray)】

- 双曲線正接

y = np.array([-np.inf, -2, -1, 0, 1, 2, np.inf]) print(np.tanh(y)) # [-1. -0.96402758 -0.76159416 0. 0.76159416 0.96402758 1.]P. 逆三角関数

ndarrayの各値に、逆三角関数を適用する。

【

arcsin(ndarray)】

- 逆正弦

y = np.linspace(-1, 1, 5) print(np.arcsin(y)) # [-1.57079633 -0.52359878 0. 0.52359878 1.57079633]【

arccos(ndarray)】

- 逆余弦

y = np.linspace(-1, 1, 5) print(np.arccos(y)) # [3.14159265 2.0943951 1.57079633 1.04719755 0.]【

arctan(ndarray)】

- 逆正接

y = np.linspace(-1, 1, 5) print(np.arctan(y)) # [-0.78539816 -0.46364761 0. 0.46364761 0.78539816]Q. 逆双曲線関数

ndarrayの各値に、逆双曲線関数を適用する。

【

arcsinh(ndarray)】

- 逆双曲線正弦

y = np.array([-np.inf, -3.62686041, -1.17520119, 0., 1.17520119, 3.62686041, np.inf]) print(np.arcsinh(y)) # [-inf -2. -1. 0. 1. 2. inf]【

arccosh(ndarray)】

- 逆双曲線余弦

y = np.array([1., 1.54308063, 3.76219569, np.inf]) print(np.arccosh(y)) # [ 0. 1. 2. inf]【

arctanh(ndarray)】

- 逆双曲線正接

y = np.array([-1., -0.96402758, -0.76159416, 0., 0.76159416, 0.96402758, 1.]) print(np.arctanh(y)) # [-inf -2. -1.00000001 0. 1.00000001 2. inf]R. 乱数生成

Numpyで乱数生成する。

【

numpy.random.rand(d0, d1, ..., dn)】

- 一様分布

- 指定した要素数/次元数の乱数配列を生成する。(乱数の範囲:0以上1未満)

print(np.random.rand()) # 0.5504876218756463 print(np.random.rand(2)) # [0.70029403 0.48969378] print(np.random.rand(2, 2)) # [[0.98181874 0.47001957] # [0.79277853 0.12536121]]【

numpy.random.randint(low, high=None, size=None, dtype='l')】

- 一様分布

- 指定範囲の整数での乱数を生成する。

- low:最小値(以上。乱数の範囲に含まれる)

- high:最大値(未満。乱数の範囲に含まれない)

- size:要素数/次元数

- dtype:データ型

print(np.random.randint(1,4)) # 2 print(np.random.randint(1,4, 2)) # [2 2] print(np.random.randint(1,4, (2, 2))) # [[3 2] # [3 1]]【

numpy.random.uniform(low=0.0, high=1.0, size=None)】

- 一様分布

- 指定範囲の乱数を生成する。

- low:最小値(以上。乱数の範囲に含まれる)

- high:最大値(未満。乱数の範囲に含まれない)

- size:要素数/次元数

print(np.random.uniform(1,4)) # 3.5515484791542056 print(np.random.uniform(1,4, 2)) # [1.51270014 3.02435494] print(np.random.uniform(1,4, (2, 2))) # [[3.47188029 1.17177563] # [3.87198389 3.91458379]]【

numpy.random.randn(d0, d1, ..., dn)】

- 正規分布

- 指定した要素数/次元数の乱数配列を生成する。(平均:0, 標準偏差:1)

print(np.random.randn()) # -0.5775065521096695 print(np.random.randn(2)) # [-1.50501689 1.46743032] print(np.random.randn(2, 2)) # [[ 1.16357112 -0.24601519] # [ 2.07269576 -0.39272309]]【

numpy.random.normal(loc=0.0, scale=1.0, size=None)】

- 正規分布

- 指定の平均・標準偏差の乱数を生成する。

- loc:平均

- scale:標準偏差

- size:要素数/次元数

print(np.random.normal(50, 10)) # 63.47995333571061 print(np.random.normal(50, 10, (2, 2))) # [[56.02364177 55.25423891] # [45.44840171 29.8303964 ]] print(np.random.normal((50, 0), (10, 1), (5, 2))) # [[45.48754234 -0.74792452] # [60.84696747 1.01209036] # [42.38844146 -0.10453915] # [39.77544056 1.22264549] # [41.60250782 1.64150462]]【

numpy.random.binomial(n, p, size=None)】

- 二項分布

- 指定の試行数・確率の乱数を生成する。

- n :試行数

- p:確率

- size:要素数/次元数

print(np.random.binomial(100, 0.5)) # 53 print(np.random.binomial(100, 0.5, (2, 2))) # [[53 53] # [48 50]] print(np.random.binomial((100, 1000), (0.3, 0.7), (5, 2))) # [[ 33 699] # [ 30 660] # [ 34 698] # [ 26 688] # [ 25 683]]【

numpy.random.beta(a, b, size=None)】

- ベータ分布

print(np.random.beta(3, 5)) # 0.09838262724430759 print(np.random.beta(8, 2, (2, 2))) # [[0.92800788 0.86391443] # [0.67249524 0.97299346]] print(np.random.beta((3, 8), (5, 2), (5, 2))) # [[0.11825463 0.74320634] # [0.24992266 0.79029969] # [0.13345269 0.57807883] # [0.32374525 0.92666103] # [0.64669681 0.84867388]]【

numpy.random.chisquare(df, size=None)

- カイ二乗分布

print(np.random.chisquare(1)) # 0.05074259859574817 print(np.random.chisquare(5, (2, 2))) # [[ 6.15617206 5.54859677] # [ 2.60704305 10.35079434]] print(np.random.chisquare((1, 5), (5, 2))) # [[2.3942405 6.43803251] # [1.97544231 2.73456762] # [0.63389405 7.81526263] # [0.05035459 7.8224598 ] # [1.01597309 1.46098368]]【

numpy.random.gamma(shape, scale=1.0, size=None)】

- ガンマ分布

- shape:形状パラメータ k

- scale:尺度パラメータ θ

print(np.random.gamma(1, 2)) # 0.48471788864900295 print(np.random.gamma(9, 1, (2, 2))) # [[10.71101589 16.68686166] # [ 5.22150652 5.87160223]] print(np.random.gamma((1, 9), (2, 1), (5, 2))) # [[ 3.4102224 6.31938602] # [ 0.03882968 7.71108072] # [ 2.62781738 10.70853193] # [ 5.07929584 5.83489052] # [ 1.50577929 11.21572879]]S. 基本統計

ndarrayの値から基本統計量を算出する。

【

max】

- 最大値

a = np.array([10, 20, 30, 40, 50]) print(np.max(a)) # 50【

argmax】

- 最大値のインデックス

a = np.array([10, 20, 30, 40, 50]) print(np.argmax(a)) # 4【

min】

- 最小値

a = np.array([10, 20, 30, 40, 50]) print(np.min(a)) # 10【

argmin】

- 最小値のインデックス

a = np.array([10, 20, 30, 40, 50]) print(np.argmin(a)) # 0【

sum】

- 合計

a = np.array([10, 20, 30, 40, 50]) print(np.sum(a)) # 150【

mean】

- 平均値

a = np.array([10, 20, 30, 40, 50]) print(np.mean(a)) # 30.0【

var】

- 分散

a = np.array([10, 20, 30, 40, 50]) print(np.var(a)) # 200.0【

std】

- 標準偏差

a = np.array([10, 20, 30, 40, 50]) print(np.std(a)) # 14.142135623730951【

cumsum】

- 累積和

a = np.array([10, 20, 30, 40, 50]) print(np.cumsum(a)) # [ 10 30 60 100 150]【

cumsum】

- 累積積

a = np.array([10, 20, 30, 40, 50]) print(np.cumprod(a)) # [ 10 200 6000 240000 12000000]T. 検証処理

値の検証処理を行う。

【

isnan(ndarray)】

- NaN(Not a number)か否かの判定

y = np.array([np.nan, np.inf, 0, 1]) print(np.isnan(y)) # [ True False False False]【

isfinite(ndarray)】

- 有限(無限でもなくNaNでもない)か否かの判定

y = np.array([np.nan, np.inf, -np.inf, 0, 1]) print(np.isfinite(y)) # [False False False True True]【

isfin(ndarray)】

- 無限(有限でもなくNaNでもない)か否かの判定

y = np.array([np.nan, np.inf, -np.inf, 0, 1]) print(np.isinf(y)) # [False True True False False]【

sign(ndarray)】

- 符号の判定

y = np.array([-np.inf, -5, 0, 5, np.inf]) print(np.sign(y)) # [-1. -1. 0. 1. 1.]備考

本記事はブログ「雑用エンジニアの技術ノート」からの移行記事です。先のブログは削除予定です。

- 投稿日:2020-09-13T18:35:36+09:00

[CovsirPhy] COVID-19データ解析用Pythonパッケージ: Parameter estimation

Introduction

COVID-19のデータ(PCR陽性者数など)のデータを簡単にダウンロードして解析できるPythonパッケージ CovsirPhyを作成しています。

紹介記事:

今回はParameter estimation(SIR-F modelなどのパラメータ推定)のご紹介です。

英語版のドキュメントはCovsirPhy: COVID-19 analysis with phase-dependent SIRs, Kaggle: COVID-19 data with SIR modelをご参照ください。

1. 実行環境

CovsirPhyは下記方法でインストールできます!Python 3.7以上, もしくはGoogle Colaboratoryをご使用ください。

- 安定版:

pip install covsirphy --upgrade- 開発版:

pip install "git+https://github.com/lisphilar/covid19-sir.git#egg=covsirphy"import covsirphy as cs cs.__version__ # '2.8.2'

実行環境 OS Windows Subsystem for Linux / Ubuntu Python version 3.8.5 2. 準備

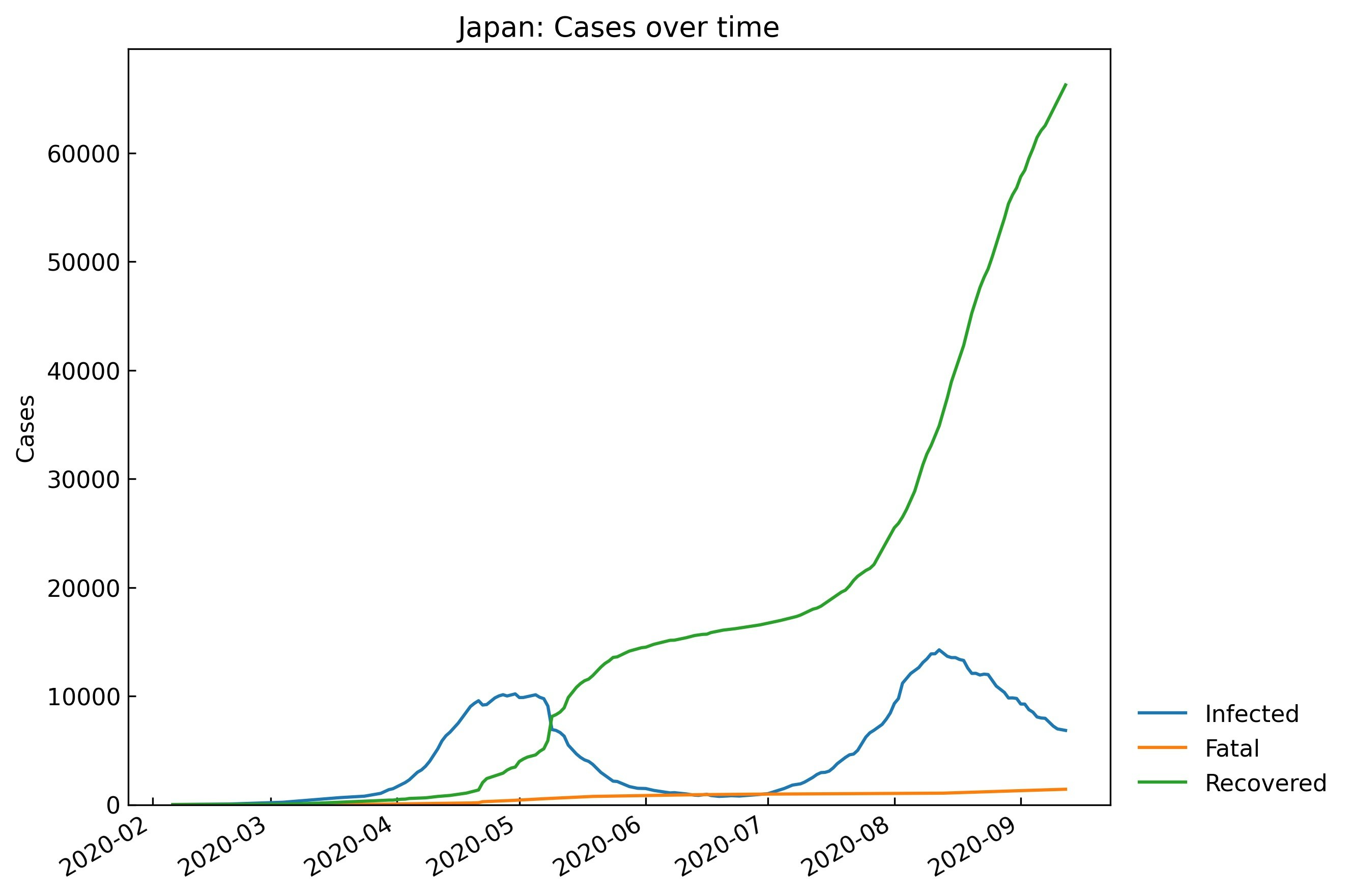

本記事の表及びグラフは2020/9/12時点のデータを使用して作成しました。実データをCOVID-19 Data Hub1よりダウンロードするコード2はこちら:

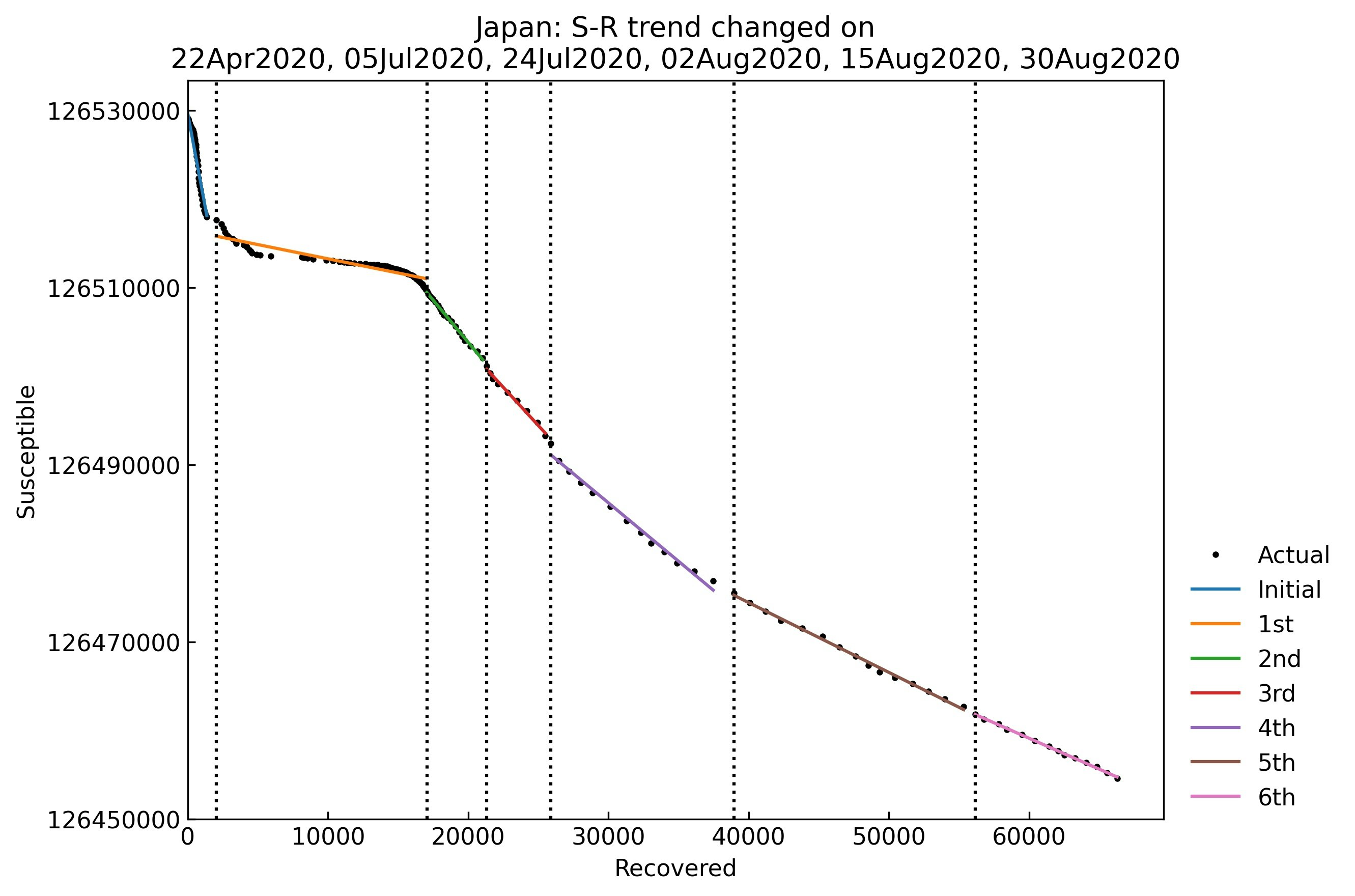

data_loader = cs.DataLoader("input") jhu_data = data_loader.jhu() population_data = data_loader.population()また、下記コードにより実データの確認とS-R trend analysis(感染拡大状況のトレンドの分析法)3を実行してください。

# (Optional) 厚生労働省データの取得 japan_data = data_loader.japan() jhu_data.replace(japan_data) print(japan_data.citation) # 解析用クラスのインスタンス生成 snl = cs.Scenario(jhu_data, population_data, country="Japan") # 実データの確認 snl.records(filename=None) # S-R trend analysis snl.trend(filename=None) # Phase設定の確認 snl.summary()Phase設定:

Type Start End Population 0th Past 06Feb2020 21Apr2020 126529100 1st Past 22Apr2020 04Jul2020 126529100 2nd Past 05Jul2020 23Jul2020 126529100 3rd Past 24Jul2020 01Aug2020 126529100 4th Past 02Aug2020 14Aug2020 126529100 5th Past 15Aug2020 29Aug2020 126529100 6th Past 30Aug2020 12Sep2020 126529100 3. 実行例

S-R trend analysisにより、"Phase"(パラメータが一定となる期間)に分割することができました。本記事では、各"Phase"のデータ(例えば0th phaseであれば2020/2/6 - 2020/4/21のデータ)を用いてパラメータの値を推定します。

推定のしくみについては別記事を作成する予定です。

optunaパッケージを使ってパラメータの値を提案、scipy.integrate.solve_ivpによって数値解を計算、実データとの誤差の少ないパラメータセットを選び出しています。結果の見方は後述しますが、下記2行で実行・結果一覧の取得ができます。今回はSIR-F model4を使用しました。

# Parameter estimation with SIR-F model snl.estimate(cs.SIRF) # パラメータ一覧の取得 snl.summary()# 標準出力の例(CPU数などによって処理時間は異なる) # 詳細後述:最新のPhase = 6th phaseにてtauを含めた推定を行った後、tauを固定して0-5thのパラメータ推定 <SIR-F model: parameter estimation> Running optimization with 8 CPUs... 6th phase (30Aug2020 - 12Sep2020): finished 704 trials in 0 min 25 sec 5th phase (15Aug2020 - 29Aug2020): finished 965 trials in 1 min 0 sec 3rd phase (24Jul2020 - 01Aug2020): finished 965 trials in 1 min 0 sec 1st phase (22Apr2020 - 04Jul2020): finished 913 trials in 1 min 0 sec 4th phase (02Aug2020 - 14Aug2020): finished 969 trials in 1 min 0 sec 0th phase (06Feb2020 - 21Apr2020): finished 853 trials in 1 min 0 sec 2nd phase (05Jul2020 - 23Jul2020): finished 964 trials in 1 min 0 sec Completed optimization. Total: 1 min 27 sec

Type Start End Population ODE Rt theta kappa rho sigma tau 1/alpha2 [day] 1/gamma [day] alpha1 [-] 1/beta [day] RMSLE Trials Runtime 0th Past 06Feb2020 21Apr2020 126529100 SIR-F 5.54 0.0258495 0.0002422 0.0322916 0.00543343 480 1376 61 0.026 10 1.17429 804 1 min 0 sec 1st Past 22Apr2020 04Jul2020 126529100 SIR-F 0.41 0.0730748 0.000267108 0.0118168 0.0264994 480 1247 12 0.073 28 1.11459 861 1 min 0 sec 2nd Past 05Jul2020 23Jul2020 126529100 SIR-F 2.01 0.000344333 7.92419e-05 0.0467789 0.023201 480 4206 14 0 7 0.0331522 910 1 min 0 sec 3rd Past 24Jul2020 01Aug2020 126529100 SIR-F 1.75 0.00169155 4.05087e-05 0.0459332 0.0260965 480 8228 12 0.002 7 0.0201773 923 1 min 0 sec 4th Past 02Aug2020 14Aug2020 126529100 SIR-F 1.46 0.000634554 0.000116581 0.0325815 0.0221345 480 2859 15 0.001 10 0.0751473 909 1 min 0 sec 5th Past 15Aug2020 29Aug2020 126529100 SIR-F 0.8 0.00244294 9.30884e-05 0.0272693 0.0337857 480 3580 9 0.002 12 0.0420563 907 1 min 0 sec 6th Past 30Aug2020 12Sep2020 126529100 SIR-F 0.69 5.36037e-05 0.000467824 0.0219379 0.0312686 480 712 10 0 15 0.0132161 724 0 min 25 sec 4. パラメータ推定値

横に長いので順番に見ていきましょう。まずはパラメータの推定値です。

# cs.SIRF.PARAMETERS: SIR-F modelのパラメータ名リスト cols = ["Start", "End", "ODE", "tau", *cs.SIRF.PARAMETERS] snl.summary(columns=cols)

Start End ODE tau theta kappa rho sigma 0th 06Feb2020 21Apr2020 SIR-F 480 0.0258495 0.0002422 0.0322916 0.00543343 1st 22Apr2020 04Jul2020 SIR-F 480 0.0730748 0.000267108 0.0118168 0.0264994 2nd 05Jul2020 23Jul2020 SIR-F 480 0.000344333 7.92419e-05 0.0467789 0.023201 3rd 24Jul2020 01Aug2020 SIR-F 480 0.00169155 4.05087e-05 0.0459332 0.0260965 4th 02Aug2020 14Aug2020 SIR-F 480 0.000634554 0.000116581 0.0325815 0.0221345 5th 15Aug2020 29Aug2020 SIR-F 480 0.000644851 0.000383424 0.0274104 0.0337156 6th 30Aug2020 12Sep2020 SIR-F 480 5.36037e-05 0.000467824 0.0219379 0.0312686 SIR-F model4:

\begin{align*} \mathrm{S} \overset{\beta I}{\longrightarrow} \mathrm{S}^\ast \overset{\alpha_1}{\longrightarrow}\ & \mathrm{F} \\ \mathrm{S}^\ast \overset{1 - \alpha_1}{\longrightarrow}\ & \mathrm{I} \overset{\gamma}{\longrightarrow} \mathrm{R} \\ & \mathrm{I} \overset{\alpha_2}{\longrightarrow} \mathrm{F} \\ \end{align*}$\alpha_2$, $\beta$, $\gamma$は「時間」を次元として有しています。この「時間」は連立常微分方程式$f'(T)=x(T)$を離散化した方程式$f(T+\Delta T) - f(T) = x(T) \Delta T$の$\Delta T$に依存しています。1日おきにデータを取得している以上$\Delta T$は1日(=1440 min)未満となりますが、具体的な値はわかりません。国や地域によって異なる可能性もあり、異なる国の有次元パラメータ$\alpha_2$, $\beta$, $\gamma$の比較を行うことは困難です。

そこで$\Delta T$に相当する変数$\tau$を設定し、有次元のパラメータを無次元化しました。

\begin{align*} (S, I, R, F) = & N \times (x, y, z, w) \\ (T, \alpha_1, \alpha_2, \beta, \gamma) = & (\tau t, \theta, \tau^{-1}\kappa, \tau^{-1}\rho, \tau^{-1}\sigma) \\ 1 \leq \tau & \leq 1440 \\ \end{align*}このとき4、

\begin{align*} & 0 \leq (x, y, z, w, \theta, \kappa, \rho, \sigma) \leq 1 \\ \end{align*}同一国内では$\tau$の値が一定となるように、最新のPhaseデータを用いて$\tau$と無次元パラメータを推定した後、他のPhaseのパラメータ推定時には同じ値を$\tau$として使用するようにしています。今回は表の通り480 minとなりました。計算を単純化するため1日=1440 minの約数を使用するようにプログラミングしています。

では、各無次元パラメータの推移をグラフ化してみましょう。

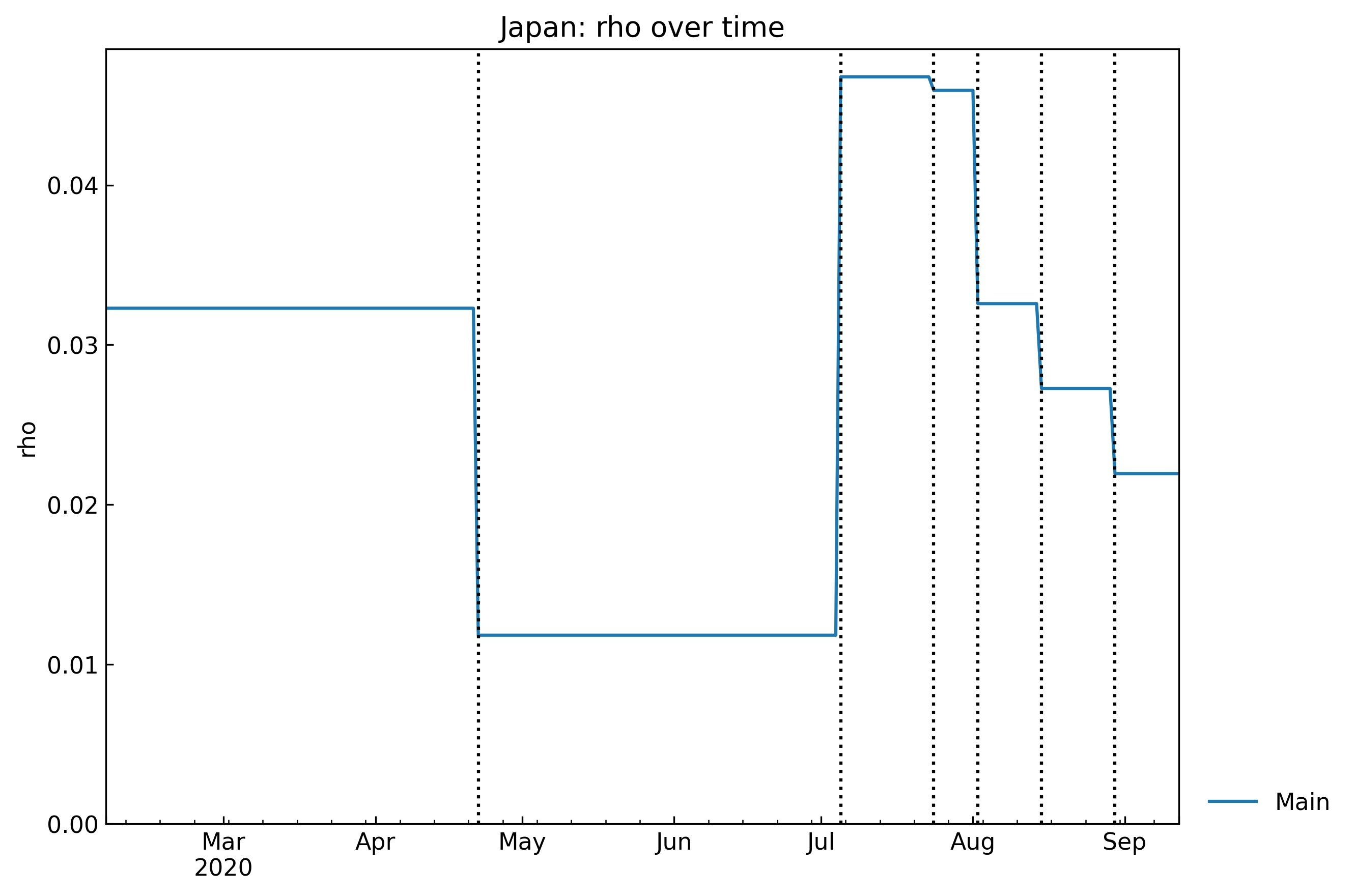

\begin{align*} & \frac{\mathrm{d}x}{\mathrm{d}t}= - \rho x y \\ & \frac{\mathrm{d}y}{\mathrm{d}t}= \rho (1-\theta) x y - (\sigma + \kappa) y \\ & \frac{\mathrm{d}z}{\mathrm{d}t}= \sigma y \\ & \frac{\mathrm{d}w}{\mathrm{d}t}= \rho \theta x y + \kappa y \\ \end{align*}rhoの推移

Susceptible(感受性保持者)がInfected(感染者)と接触したとき、感染する確率 $\rho$の推移:

snl.history(target="rho", filename=None)緊急事態宣言(区域限定2020/4/7, 全国2020/4/16, 全国で解除2020/5/25)の効果が4月後半に現れ、7月初旬まで維持されていた、と解釈しています。その後はね上がり、少しずつ低下してきています。詳細については議論が必要ですが、3密回避などの対策の効果が直接的に反映されるパラメータとなっています。

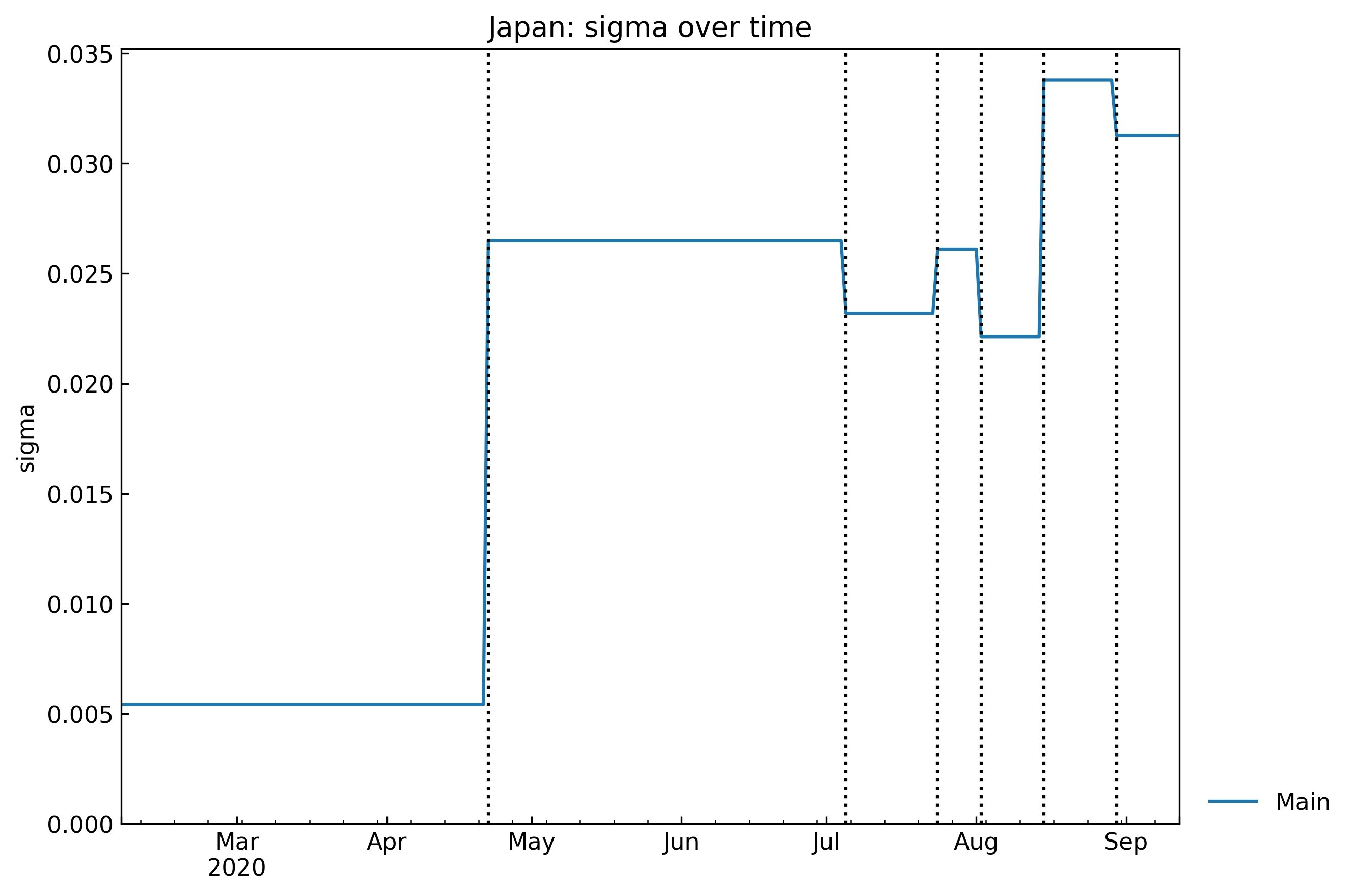

sigmaの推移

InfectedからRecovered(回復者)に移行する確率 $\sigma$の推移:

snl.history(target="sigma", filename=None)4月後半に大きく上昇した後、上昇/下降を繰り返しながら上昇傾向にあります。医療提供体制、新薬の開発/供給状況が反映されるパラメータです。

kappaの推移

感染者の死亡率$\kappa$の推移:

snl.history(target="kappa", filename=None)大きく変動しているように見えますが、値の絶対値が小さいため、ある程度一定に抑えられていると考えてよいのではないでしょうか(他国との比較による検証が必要)。医療体制を整え、新薬の十分な供給により$\kappa$を限りなく0に近づけていくことが必要です。

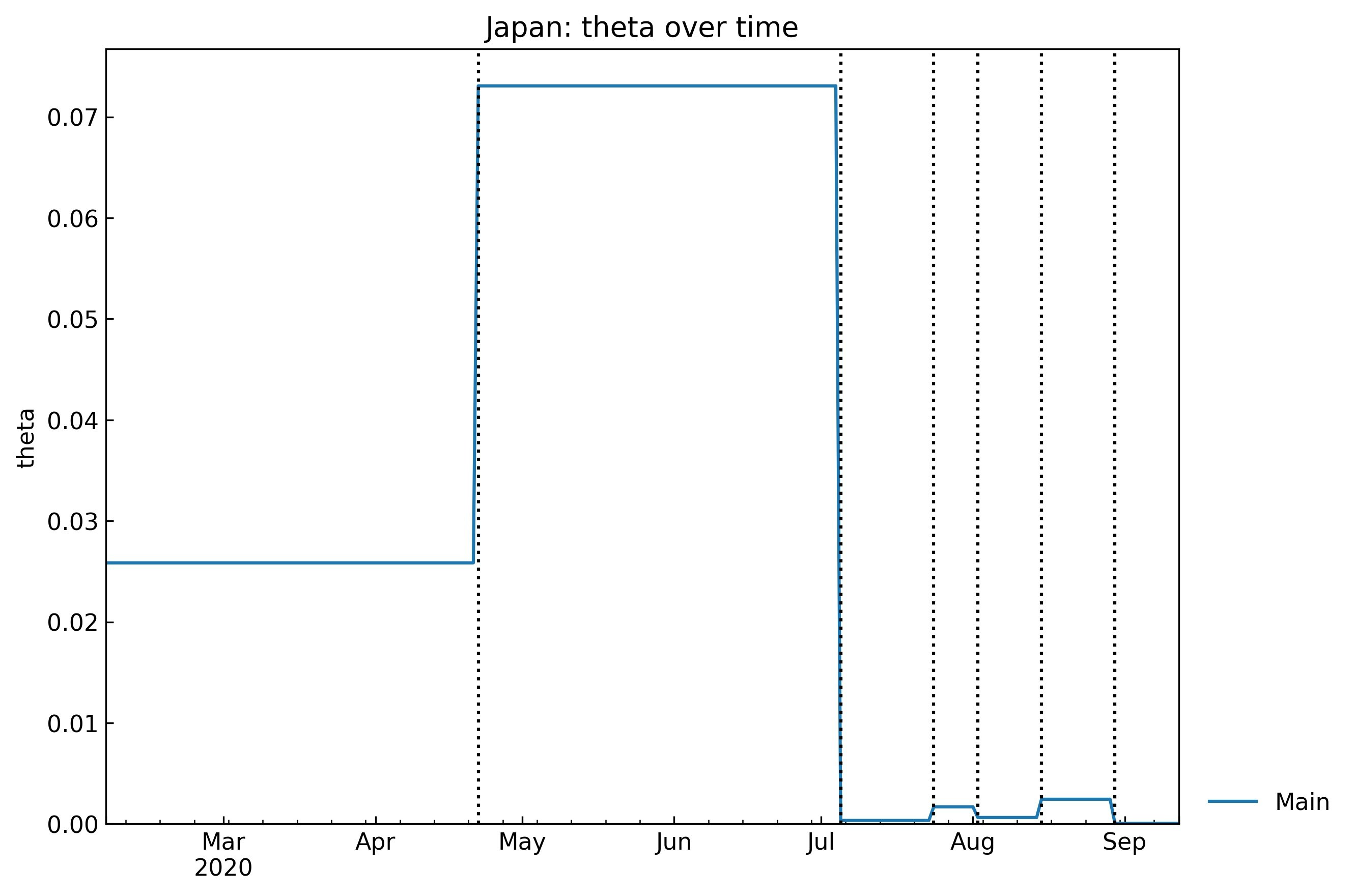

thetaの推移

確定診断を受けた感染者のうち、確定診断の時点で亡くなっていた感染者の割合$\theta$の推移:

snl.history(target="theta", filename=None)感染初期においては医療提供体制自体が極めて逼迫していたため解釈は難しいですが、検査が遅れて適切な治療を行えなかった場合などに値が上昇すると考えられます。

5. 有次元パラメータの推移

有次元のパラメータについても表に含まれています。解釈しやすくするため、もともと無次元の$\alpha_1$を除き、逆数にして単位を[day]にしています。

cols = ["Start", "End", "ODE", "tau", *cs.SIRF.DAY_PARAMETERS] fh.write(snl.summary(columns=cols).to_markdown())

Start End ODE tau alpha1 [-] 1/alpha2 [day] 1/beta [day] 1/gamma [day] 0th 06Feb2020 21Apr2020 SIR-F 480 0.026 1376 10 61 1st 22Apr2020 04Jul2020 SIR-F 480 0.073 1247 28 12 2nd 05Jul2020 23Jul2020 SIR-F 480 0 4206 7 14 3rd 24Jul2020 01Aug2020 SIR-F 480 0.002 8228 7 12 4th 02Aug2020 14Aug2020 SIR-F 480 0.001 2859 10 15 5th 15Aug2020 29Aug2020 SIR-F 480 0.002 3580 12 9 6th 30Aug2020 12Sep2020 SIR-F 480 0 712 15 10 有次元パラメータは無次元パラメータと同じ経過を示すため省略しますが、グラフは下記コードで取得できます。

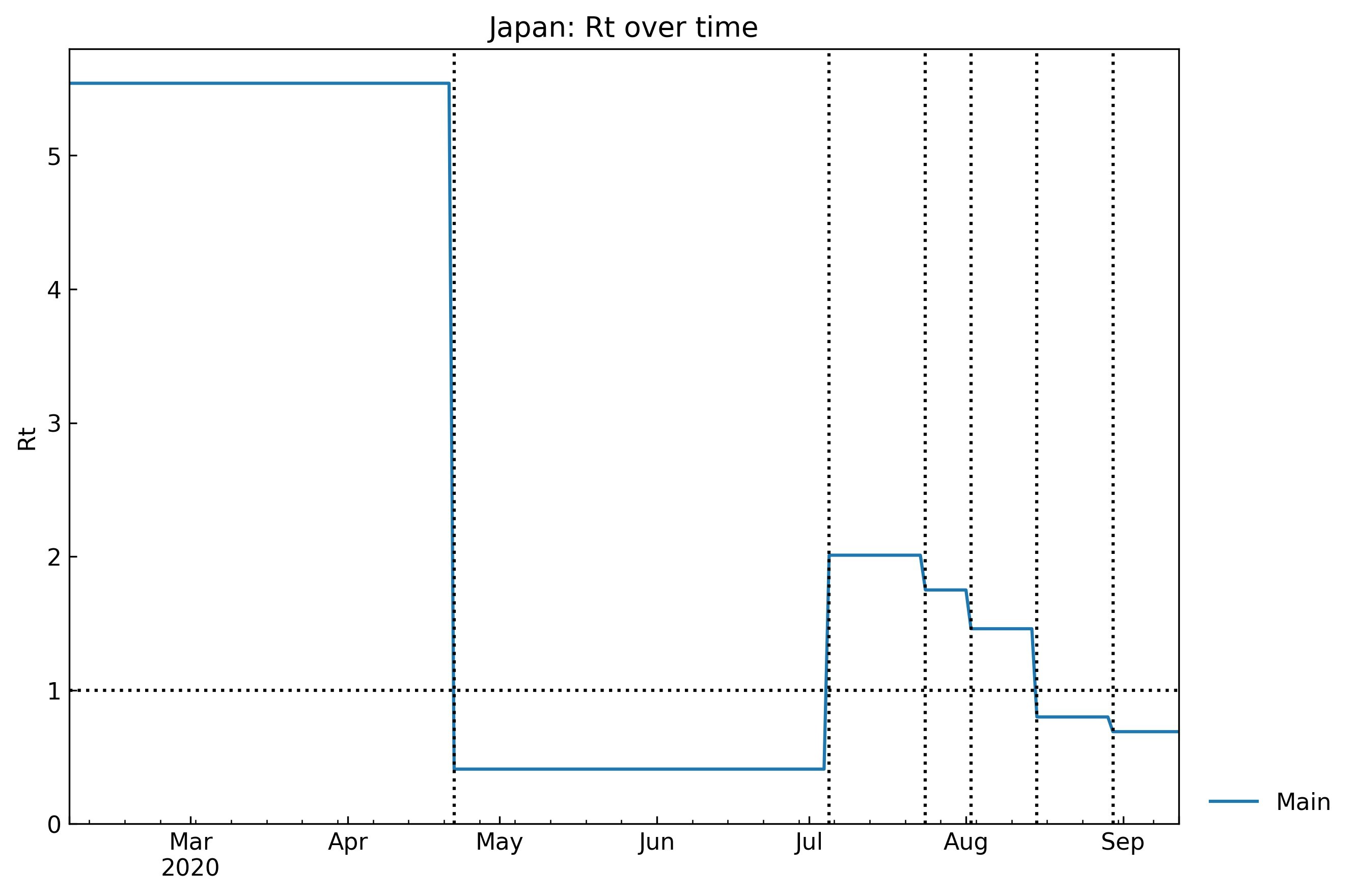

# betaの場合 -> グラフ省略 snl.history(target="1/beta [day]", filename=None)6. 実効産生産数の推移

SIR-F model4の基本/実効産生産数Rtは次の通り定義しています。

\begin{align*} R_t = \rho (1 - \theta) (\sigma + \kappa)^{-1} = \beta (1 - \alpha_1) (\gamma + \alpha_2)^{-1} \end{align*}推移:

# 一覧 cols = ["Start", "End", "ODE", "tau", "Rt"] snl.summary(columns=cols) # グラフ snl.history(target="Rt", filename="rt.jpg")

Start End ODE Rt 0th 06Feb2020 21Apr2020 SIR-F 5.54 1st 22Apr2020 04Jul2020 SIR-F 0.41 2nd 05Jul2020 23Jul2020 SIR-F 2.01 3rd 24Jul2020 01Aug2020 SIR-F 1.75 4th 02Aug2020 14Aug2020 SIR-F 1.46 5th 15Aug2020 29Aug2020 SIR-F 0.8 6th 30Aug2020 12Sep2020 SIR-F 0.69 $Rt > 1$が感染拡大の1つの目安となるため、水平線$Rt=1$を表示させました。

7. パラメータの正確性

パラメータの正確性を測るRMSLE score, パラメータを推定するために

optunaパッケージが提案したパラメータセットの数、実行時間についても表に含まれています。cols = ["Start", "End", "RMSLE", "Trials", "Runtime"] snl.summary(columns=cols)

Start End RMSLE Trials Runtime 0th 06Feb2020 21Apr2020 1.17429 690 1 min 1 sec 1st 22Apr2020 04Jul2020 1.11459 764 1 min 0 sec 2nd 05Jul2020 23Jul2020 0.0331522 810 1 min 1 sec 3rd 24Jul2020 01Aug2020 0.0201773 816 1 min 1 sec 4th 02Aug2020 14Aug2020 0.0751473 808 1 min 0 sec 5th 15Aug2020 29Aug2020 0.0420563 804 1 min 0 sec 6th 30Aug2020 12Sep2020 0.0132161 658 0 min 25 sec RMSLE score (Root Mean Squared Log Error)5の定義式は次の通りです。0に近いほど実データをよく反映していると言えます。省略しますが、推定方法の検証自体は理論データ(SIR-F modelの式とパラメータセットの例から理論的に作成される患者数データ)を使って行っております。

\begin{align*} & \sqrt{\cfrac{1}{n}\sum_{i=1}^{n}(log_{10}(A_{i} + 1) - log_{10}(P_{i} + 1))^2} \end{align*}$A$は実データ, $P$は予測値を示しています。$i=1, 2, 3, 4(=n)$のとき、$A_i$及び$P_i$はそれぞれ$S, I, R, F$の実データ/予測値です。

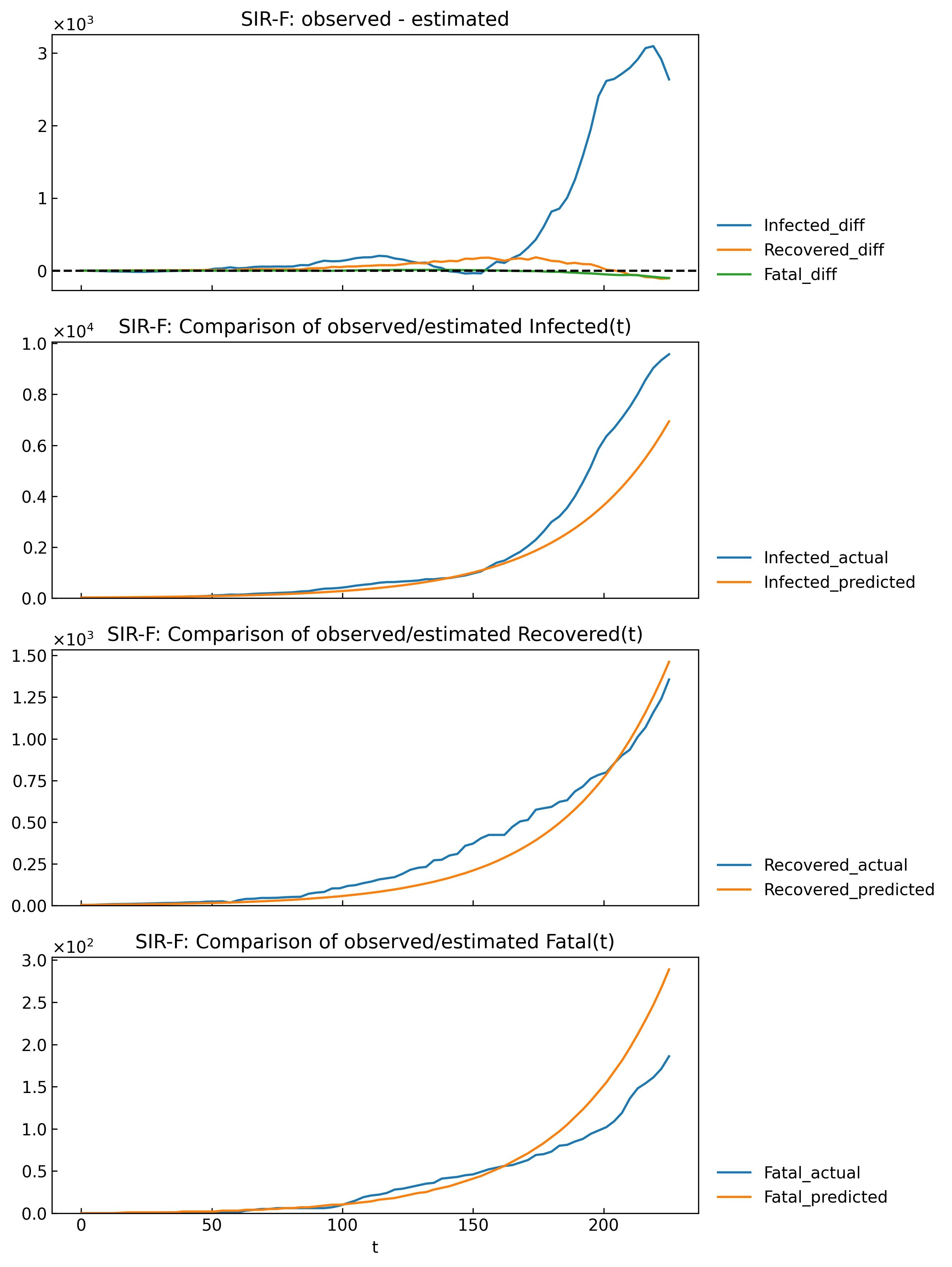

値だけではイメージがつきにくいためグラフ化してみました。まずはRMSLE値が最も大きい0th phaseについて。1番上のグラフは実データと予測値の差、2, 3, 4番目は変数ごとに実データと予測値の両方を表示しています。

snl.estimate_accuracy(phase="0th", filename=None)誤差がある程度生じています。

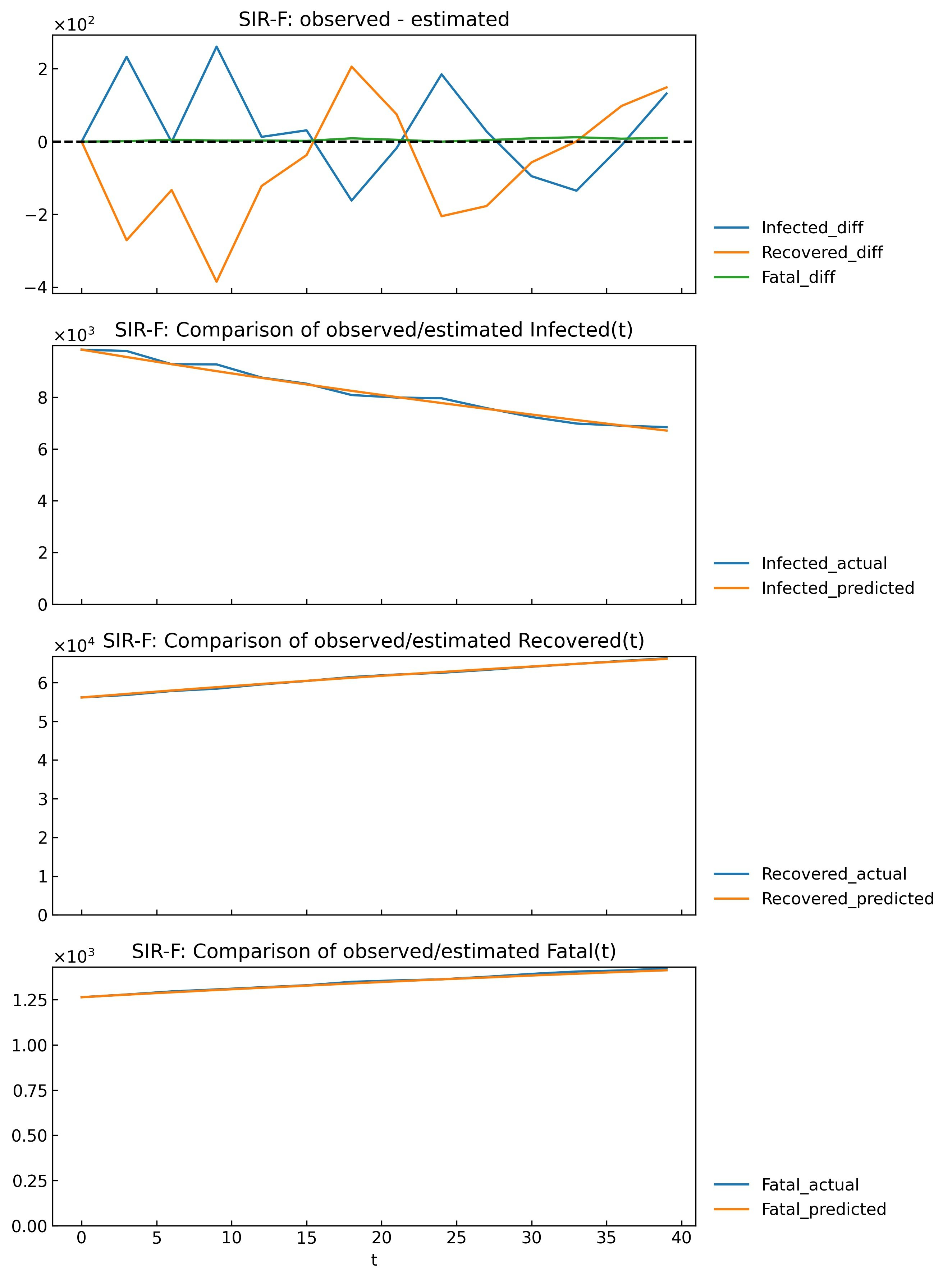

Scenario.separate()などを使って0th phaseを分割したほうが良いようです(別記事を作成予定)。一方でRMSLE scoreが最も小さい6th phaseでは実データと予測値がよく重なっています。

snl.estimate_accuracy(phase="6th", filename=None)8. あとがき

今回は各Phaseのパラメータを推定する方法についてご説明しました。流行開始から半年以上が経過し、パラメータの検証、今後のパラメータの予測、シナリオ分析が重要となる段階に来ていると思います。データサイエンスのテーマとしてCOVID-19の注目度が下がってきているようですが、データが蓄積されてきた分、ダッシュボードの作成に注力していた初期の頃より深い分析ができるようになってきました。

今回もお疲れさまでした!

Guidotti, E., Ardia, D., (2020), “COVID-19 Data Hub”, Journal of Open Source Software 5(51):2376, doi: 10.21105/joss.02376. ↩

Please refer to What’s the Difference Between RMSE and RMSLE? ↩

- 投稿日:2020-09-13T17:08:13+09:00

Djangoを使ったWEBアプリケーションの開発【Django起動編】

前提・環境

MacbookPro2017 13inch macOS Catalina 10.15.6

Python 3.6

Djanngo version 3.1.1 ←インストール手順書き忘れてました。そのうち書くかも。プロジェクトの作成とファイル構成の確認

今回は、djangoフォルダを作成し、その中にプロジェクトを作成していく。

コマンドプロンプトで下記を入力する。$ mkdir django $ cd django「django」フォルダに移動したら、下記を入力するとプロジェクトが作成される。

今回プロジェクト名は「project1」とした。$ django-admin startproject project1実行後、作成されたproject1フォルダ内に移動し、ファイルを確認する。

$ cd project1 $ ls manage.py project1さらに、project1フォルダ内のproject1フォルダに移動し、ファイルを確認する。

$ cd project1 $ ls __init__.py asgi.py settings.py urls.py wsgi.py以上のファイルが作成されていることを確認したら、一つ上のフォルダに戻ってDjangoサーバーの起動し動作を確認する。