- 投稿日:2020-05-27T23:40:59+09:00

ゼロから始めるLeetCode Day38「208. Implement Trie (Prefix Tree)」

概要

海外ではエンジニアの面接においてコーディングテストというものが行われるらしく、多くの場合、特定の関数やクラスをお題に沿って実装するという物がメインである。

その対策としてLeetCodeなるサイトで対策を行うようだ。

早い話が本場でも行われているようなコーディングテストに耐えうるようなアルゴリズム力を鍛えるサイト。

せっかくだし人並みのアルゴリズム力くらいは持っておいた方がいいだろうということで不定期に問題を解いてその時に考えたやり方をメモ的に書いていこうかと思います。

前回

ゼロから始めるLeetCode Day37「105. Construct Binary Tree from Preorder and Inorder Traversal」

今はTop 100 Liked QuestionsのMediumを解いています。

Easyは全て解いたので気になる方は目次の方へどうぞ。Twitterやってます。

問題

208. Implement Trie (Prefix Tree)

難易度はMedium。

Top 100 Liked Questionsからの抜粋です。問題としては、insert関数、search関数、startsWith関数をTrieというクラスにまとめて実装してください、というものです。

なお、それぞれの挙動としては、

Trie trie = new Trie();

trie.insert("apple");

trie.search("apple"); // returns true

trie.search("app"); // returns false

trie.startsWith("app"); // returns true

trie.insert("app");

trie.search("app"); // returns trueこのようになります。

解法

基本的に全ての引数を一度for文でチェックし、元々保持している

elementの中に存在しない場合はFalseを返すか、{}を代入するというものです。class Trie: def __init__(self): """ Initialize your data structure here. """ self.element = {} def insert(self, word: str) -> None: """ Inserts a word into the trie. """ inserted = self.element for tmp in word: if tmp not in inserted: inserted[tmp] = {} inserted = inserted[tmp] inserted["-"] = True def search(self, word: str) -> bool: """ Returns if the word is in the trie. """ searched = self.element for tmp in word: if tmp not in searched: return False searched = searched[tmp] return "-" in searched def startsWith(self, prefix: str) -> bool: """ Returns if there is any word in the trie that starts with the given prefix. """ started = self.element for tmp in prefix: if tmp not in started: return False started = started[tmp] return True # Your Trie object will be instantiated and called as such: # obj = Trie() # obj.insert(word) # param_2 = obj.search(word) # param_3 = obj.startsWith(prefix) # Runtime: 128 ms, faster than 94.63% of Python3 online submissions for Implement Trie (Prefix Tree). # Memory Usage: 27.3 MB, less than 66.67% of Python3 online submissions for Implement Trie (Prefix Tree).思ったよりスピードがでて良い感じに実装できました。

なお、discussをみる限り、他にメジャーな解答だったのは、

from collections import defaultdict class TrieNode(object): def __init__(self): """ Initialize your data structure here. """ self.nodes = defaultdict(TrieNode) # Easy to insert new node. self.isword = False # True for the end of the trie. class Trie(object): def __init__(self): self.root = TrieNode() def insert(self, word): """ Inserts a word into the trie. :type word: str :rtype: void """ curr = self.root for char in word: curr = curr.nodes[char] curr.isword = True def search(self, word): """ Returns if the word is in the trie. :type word: str :rtype: bool """ curr = self.root for char in word: if char not in curr.nodes: return False curr = curr.nodes[char] return curr.isword def startsWith(self, prefix): """ Returns if there is any word in the trie that starts with the given prefix. :type prefix: str :rtype: bool """ curr = self.root for char in prefix: if char not in curr.nodes: return False curr = curr.nodes[char] return True # Runtime: 192 ms, faster than 57.66% of Python3 online submissions for Implement Trie (Prefix Tree). # Memory Usage: 32.5 MB, less than 7.41% of Python3 online submissions for Implement Trie (Prefix Tree).こういったものでした。

TrieNodeというクラスを別に作り、defaultdictというものを使っていますね。

ただ、今回に関していえば前者の回答の方が分かりやすく、そして速いと思うのでそちらの方が良いのかなとは思います。今回はこんな感じです、お疲れ様でした。

- 投稿日:2020-05-27T23:05:14+09:00

【Python】月の初日や最終日を取得する方法

結論

replaceメソッドを使うと楽チン。

from datetime import datetime from dateutil.relativedelta import relativedelta today = datetime.now().date() print(today) # => 2020-05-27 last_month_start = (today - relativedelta(months=1)).replace(day=1) print(last_month_start) # => 2020-04-01 last_month_end = today.replace(day=1) - relativedelta(days=1) print(last_month_end) # => 2020-04-30変数名がアレなのは見逃してください。

参考

https://www.lifewithpython.com/2018/06/python-get-first-and-last-day-of-month.html

- 投稿日:2020-05-27T22:40:02+09:00

可視化ツールいろいろ

目的

分析コンペの効率化のための、可視化ツールのいろいろまとめ。

1.相関マップ

pandasデータフレームの各列の相関をヒートマップ表示。

各特徴量の相関、モデルのアンサンブル用の予測結果の相関に使用する。参考

-

コード

fig ,ax = plt.subplots(1,1,figsize=(12,12)) sns.heatmap(df.corr(), annot=True, fmt='.7f', ax=ax) df.corr()2.混同行列(Confusion Matrix)

参考

-

コード

import numpy as np import pandas as pd from scipy import signal from sklearn.metrics import confusion_matrix, f1_score, plot_confusion_matrix # Thanks to https://www.kaggle.com/marcovasquez/basic-nlp-with-tensorflow-and-wordcloud def plot_cm(y_true, y_pred, title="", figsize=(14,14): y_pred = y_pred.astype(int) cm = confusion_matrix(y_true, y_pred, labels=np.unique(y_true)) cm_sum = np.sum(cm, axis=1, keepdims=True) cm_perc = cm / cm_sum.astype(float) * 100 annot = np.empty_like(cm).astype(str) nrows, ncols = cm.shape for i in range(nrows): for j in range(ncols): c = cm[i, j] p = cm_perc[i, j] if i == j: s = cm_sum[i] annot[i, j] = '%.1f%%\n%d/%d' % (p, c, s) elif c == 0: annot[i, j] = '' else: annot[i, j] = '%.1f%%\n%d' % (p, c) cm = pd.DataFrame(cm, index=np.unique(y_true), columns=np.unique(y_true)) cm.index.name = 'Actual' cm.columns.name = 'Predicted' fig, ax = plt.subplots(figsize=figsize) plt.title(title) sns.heatmap(cm, cmap='viridis', annot=annot, fmt='', ax=ax)

- 投稿日:2020-05-27T22:40:02+09:00

Python可視化ツールいろいろ

目的

分析コンペの効率化のための、可視化ツールのいろいろまとめ。

少しずつ、増やしていく!1.相関マップ

pandasデータフレームの各列の相関をヒートマップ表示。

各特徴量の相関、モデルのアンサンブル用の予測結果の相関に使用する。参考

-

コード

fig ,ax = plt.subplots(1,1,figsize=(12,12)) sns.heatmap(df.corr(), annot=True, fmt='.7f', ax=ax) df.corr()2.混同行列(Confusion Matrix)

参考

-

コード

import numpy as np import pandas as pd from scipy import signal from sklearn.metrics import confusion_matrix, f1_score, plot_confusion_matrix # Thanks to https://www.kaggle.com/marcovasquez/basic-nlp-with-tensorflow-and-wordcloud def plot_cm(y_true, y_pred, title="", figsize=(14,14): y_pred = y_pred.astype(int) cm = confusion_matrix(y_true, y_pred, labels=np.unique(y_true)) cm_sum = np.sum(cm, axis=1, keepdims=True) cm_perc = cm / cm_sum.astype(float) * 100 annot = np.empty_like(cm).astype(str) nrows, ncols = cm.shape for i in range(nrows): for j in range(ncols): c = cm[i, j] p = cm_perc[i, j] if i == j: s = cm_sum[i] annot[i, j] = '%.1f%%\n%d/%d' % (p, c, s) elif c == 0: annot[i, j] = '' else: annot[i, j] = '%.1f%%\n%d' % (p, c) cm = pd.DataFrame(cm, index=np.unique(y_true), columns=np.unique(y_true)) cm.index.name = 'Actual' cm.columns.name = 'Predicted' fig, ax = plt.subplots(figsize=figsize) plt.title(title) sns.heatmap(cm, cmap='viridis', annot=annot, fmt='', ax=ax)

- 投稿日:2020-05-27T22:27:31+09:00

Python と VSCode で競プロ - 標準入力の簡易化とサンプルケース判定の自動化 -

最近 AtCoder で競プロを始めました

始めたのはいいのですが、パッとは解けないので何度も何度もデバッグ地獄です

そのたびターミナルにテストケースをコピペの嵐...

もうそんなことはやめようこの記事は

windows10 1909

VSCode 1.45.1

Python 3.8.2

で確認した内容となっています。1. デバッグには sys.stdin を使おう

まずは標準入力の簡易化です。

「VSCode python 標準入力」などの条件で検索していると、teratail にこんな質問と回答がありました

VS Codeで標準入力を受け取る方法(Windows10・Python)

競プロ界隈では有名なのかわかりませんが、私が探していたのはまさにこれでした。import io import sys _INPUT = """\ 2 1 2 3 aaa """ sys.stdin = io.StringIO(_INPUT) print(int(input())) print(list(map(int, input().split()))) print(list(input())) # 出力 2 [1, 2, 3] ['a', 'a', 'a']Python ドキュメントによると sys.stdin は (

input()の呼び出しも含む) すべての対話型入力に使われるもので、io.StringIO は、要するにファイルのように文字列を読み書きするクラスのようです。

テンプレート

サンプルケースや自分で考えたテストケースとデバッグしたいコードを入れてください。test_inut.pyimport io import sys # input here _INPUT = """\ """ sys.stdin = io.StringIO(_INPUT) # your code here

なにより別ファイル( input.txt など)に書いておくのと違い、テストケースがパッと見えるのもいいですよね。

これでコピペの嵐に悩まされることはなくなりました2. online-judge-tools を使ってみよう

サンプルケースの判定を自動化するツールがあります!!それは

online-judge-tools

です。online-judge-tools はコンテストサイトからサンプルケースをスクレイピングし、判定を自動化してくれるありがたいツールです。

OS には Linux か Mac OS を推奨しますが、 Windows 上でも動作します。

と書かれている通り、私の環境では何の問題もなく動作しています。

使い方

使い方に関しては、GitHub ページの他、

Visual Studio Codeで競プロ環境構築(実践編)

AtCoderで自動サンプルテストケース&手入力値テスト実行 with VS Code

を参考にさせていただきました。フォルダ構成

AtCoder\ ├── .venv\ │ ├── .vscode\ │ └── tasks.json │ ├── sctipt\ │ └── cptest.ps1 │ ├── src\ │ └── abc000_0.py │ └── test\ └── abc000_0\ ├── sample-1.in └── sample-1.out.venv フォルダは仮想環境を構築した際の名前と読み替えてください。なくても構いません。.vscode フォルダは tasks.json を生成した際自動的に作成されます。script フォルダと src フォルダは絶対必要というわけではありません。test フォルダは cptest.ps1を実行した際に自動的に作成されます。

1. インストール

> pip install online-judge-toolspip で簡単にインストールできます。

2. ログイン

ユーザー名とパスワードを入力します。

> oj login -u ユーザー名 -p パスワード "https://atcoder.jp/"ログインできたか確認するには

> oj login --check "https://atcoder.jp/"[*] You have already signed in.と返ってくれば OK です。

3. cptest.ps1

コンテストサイトからサンプルケースを取得し、テストするスクリプトです。

以下は参考にさせていただいたスクリプトを

.ps1にし、変更を加えたものです。cptest.ps1. ".venv/Scripts/Activate.ps1" $problem_name = $Args[0] $problem_name_list = ($problem_name -split "_") $base_url = if ($problem_name_list.Length -eq 2) { $problem_name_list[0] } else { [string]::Join("-", $problem_name_list[0..-2]) } if (! (Test-Path $test_dir)) { oj dl -d test/$problem_name/ https://atcoder.jp/contests/$base_url/tasks/$problem_name } oj test -c "python src/$problem_name.py" -d test/$problem_name/私は AtCoder フォルダ内の仮想環境に online-judge-tools をインストールしたため、1行目で

.venv/Scripts/Activate.ps1を読み込み、仮想環境を activate しています。仮想環境でない方は必要ありません。また、第二回全国統一プログラミング王決定戦予選 A - Sum of Two Integers などのURLは

https://atcoder.jp/contests/nikkei2019-2-qual/tasks/nikkei2019_2_qual_a

$base_urlにハイフン、$problem_nameにアンダーバーが使われているため、_を-に変える処理を追加しています。4. tasks.json

VSCode のタスクは、様々な作業を自動化する機能で、

Ctrl+Shift+Bで実行することができます。

そこで、cptest.ps1を実行できるようにしましょう。

Ctrl+Shift+Pでコマンドパレットを開き、taskと入力すると、多くのコマンドが表示されます。その中から、「タスクの構成」→「テンプレートから tasks.json を生成」→「 Others 」と選んでいくと、tasks.json が生成されます。tasks.json{ // See https://go.microsoft.com/fwlink/?LinkId=733558 // for the documentation about the tasks.json format "version": "2.0.0", "tasks": [ { "label": "test_atcorder_sample", "group": { "kind": "build", "isDefault": true }, "type": "shell", "command": "${workspaceFolder}/script/cptest.ps1", "args": [ "${fileBasenameNoExtension}" ] } ] }これで、ファイル名が

abc060_b.pyならばCtrl+Shift+Bで> cptest.ps1 abc060_bを実行したことになります。

使い方は以上です。このツールはほかにも、提出やストレステストも行えるそうです。サンプルケースのテストを自動化できるだけでもありがたいのにどれだけですか

私はまだまだ使いこなせていないのでこれから頑張ります。さいごに

本当にデバッグが楽になりました。この記事がほかの競プロ初心者を少しでも助けることができれば幸いです。

みなさま良き競プロライフを

- 投稿日:2020-05-27T22:25:23+09:00

【言語処理100本ノック 2020】第5章: 係り受け解析

はじめに

自然言語処理の問題集として有名な言語処理100本ノックの2020年版が公開されました。

この記事では、以下の第1章から第10章のうち、第5章: 係り受け解析を解いてみた結果をまとめています。

- 第1章: 準備運動

- 第2章: UNIXコマンド

- 第3章: 正規表現

- 第4章: 形態素解析

- 第5章: 係り受け解析

- 第6章: 機械学習

- 第7章: 単語ベクトル

- 第8章: ニューラルネット

- 第9章: RNN, CNN

- 第10章: 機械翻訳

事前準備

回答にはGoogle Colaboratoryを利用しています。

Google Colaboratoryのセットアップ方法や基本的な使い方は、こちらの記事が詳しいです。

なお、以降の回答の実行結果を含むノートブックはgithubにて公開しています。第5章: 係り受け解析

夏目漱石の小説『吾輩は猫である』の文章(neko.txt)をCaboChaを使って係り受け解析し,その結果をneko.txt.cabochaというファイルに保存せよ.このファイルを用いて,以下の問に対応するプログラムを実装せよ.

まずは指定のデータをダウンロードします。

Google Colaboratoryのセル上で下記のコマンドを実行すると、カレントディレクトリに対象のファイルがダウンロードされます。!wget https://nlp100.github.io/data/neko.txt続いて、CaboChaおよびCaboChaの実行に必要なMeCabとCRF++をインストールします。

# MeCabのインストール !apt install mecab libmecab-dev mecab-ipadic-utf8# CRF++のソースファイルのダウンロード・解凍・インストール FILE_ID = "0B4y35FiV1wh7QVR6VXJ5dWExSTQ" FILE_NAME = "crfpp.tar.gz" !wget 'https://docs.google.com/uc?export=download&id=$FILE_ID' -O $FILE_NAME !tar xvf crfpp.tar.gz %cd CRF++-0.58 !./configure && make && make install && ldconfig %cd ..# CaboChaのソースファイルのダウンロード・解凍・インストール FILE_ID = "0B4y35FiV1wh7SDd1Q1dUQkZQaUU" FILE_NAME = "cabocha-0.69.tar.bz2" !wget --load-cookies /tmp/cookies.txt "https://docs.google.com/uc?export=download&confirm=$(wget --quiet --save-cookies /tmp/cookies.txt --keep-session-cookies --no-check-certificate 'https://docs.google.com/uc?export=download&id=$FILE_ID' -O- | sed -rn 's/.*confirm=([0-9A-Za-z_]+).*/\1\n/p')&id=$FILE_ID" -O $FILE_NAME && rm -rf /tmp/cookies.txt !tar -xvf cabocha-0.69.tar.bz2 %cd cabocha-0.69 !./configure -with-charset=utf-8 && make && make check && make install && ldconfig %cd ..インストールが完了したら、早速係り受け解析を行います。

以下のコマンドを実行することにより、neko.txtを係り受け解析した結果が、neko.txt.cabocbaとして出力されます。!cabocha -f1 -o neko.txt.cabocha neko.txt40. 係り受け解析結果の読み込み(形態素)

形態素を表すクラスMorphを実装せよ.このクラスは表層形(surface),基本形(base),品詞(pos),品詞細分類1(pos1)をメンバ変数に持つこととする.さらに,CaboChaの解析結果(neko.txt.cabocha)を読み込み,各文をMorphオブジェクトのリストとして表現し,3文目の形態素列を表示せよ.

class Morph: def __init__(self, morph): (surface, attr) = morph.split('\t') attr = attr.split(',') self.surface = surface self.base = attr[6] self.pos = attr[0] self.pos1 = attr[1]filename = './neko.txt.cabocha' # 文単位に分割して読込 with open(filename, mode='r', encoding='utf-8') as f: text = f.read().split('EOS\n') # 指定フォーマットに整形 sentences = [] for sentence in text: morphs = [] for line in sentence.split('\n'): if line == '' or line[0] == '*': # 文末または係り受け関係を表す行 --> スキップ continue else: # 形態素を表す行 --> Morphを適用しリストに追加 morphs.append(Morph(line)) sentences.append(morphs) # 確認 for m in sentences[2]: print(vars(m))出力{'surface': '\u3000', 'base': '\u3000', 'pos': '記号', 'pos1': '空白'} {'surface': '吾輩', 'base': '吾輩', 'pos': '名詞', 'pos1': '代名詞'} {'surface': 'は', 'base': 'は', 'pos': '助詞', 'pos1': '係助詞'} {'surface': '猫', 'base': '猫', 'pos': '名詞', 'pos1': '一般'} {'surface': 'で', 'base': 'だ', 'pos': '助動詞', 'pos1': '*'} {'surface': 'ある', 'base': 'ある', 'pos': '助動詞', 'pos1': '*'} {'surface': '。', 'base': '。', 'pos': '記号', 'pos1': '句点'}41. 係り受け解析結果の読み込み(文節・係り受け)

40に加えて,文節を表すクラスChunkを実装せよ.このクラスは形態素(Morphオブジェクト)のリスト(morphs),係り先文節インデックス番号(dst),係り元文節インデックス番号のリスト(srcs)をメンバ変数に持つこととする.さらに,入力テキストのCaboChaの解析結果を読み込み,1文をChunkオブジェクトのリストとして表現し,8文目の文節の文字列と係り先を表示せよ.第5章の残りの問題では,ここで作ったプログラムを活用せよ.

文章は文(sentence)オブジェクトのリストで表され、文オブジェクトは文節(chunk)オブジェクトのリストを要素に持ち、文節オブジェクトは形態素(morph)オブジェクトのリストを要素に持つ階層構造を考え、ここでは指定のクラス

Chunkに加え、Sentenceを実装しています。

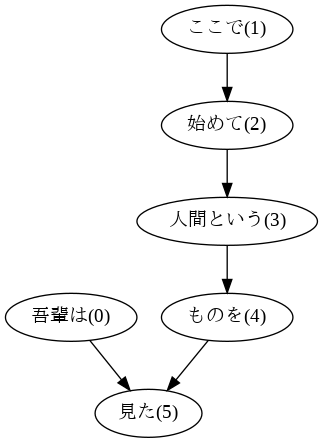

なお、Chunkオブジェクトの要素である係り元文節インデックス番号のリスト(srcs)の作成には1文のすべての文節情報を必要とするため、Sentenceオブジェクトの初期化時に作成しています。class Chunk(): def __init__(self, morphs, dst): self.morphs = morphs self.dst = dst self.srcs = [] class Sentence(): def __init__(self, chunks): self.chunks = chunks for i, chunk in enumerate(self.chunks): if chunk.dst != -1: self.chunks[chunk.dst].srcs.append(i)filename = './neko.txt.cabocha' # 文単位に分割して読込 with open(filename, mode='r', encoding='utf-8') as f: text = f.read().split('EOS\n') # 指定フォーマットに整形 sentences = [] for sentence in text: if sentence == '': # 空の文 --> 以下の処理を省略して空のSentenceオブジェクトをsentencesリストに追加 sentences.append(Sentence([])) else: chunks = [] morphs = [] dst = None for line in sentence.split('\n'): if line == '': # 文末を表す行 --> 文末直前の文節の情報にChunkを適用しchunksリストに追加 chunks.append(Chunk(morphs, dst)) elif line[0] == '*': # 係り受け関係を表す行 --> 直前の文節の情報にChunkを適用しchunksリストに追加 + 直後の文節の係り先を取得 if len(morphs) > 0: chunks.append(Chunk(morphs, dst)) morphs = [] dst = int(line.split(' ')[2].rstrip('D')) else: # 形態素を表す行 --> Morphを適用しmorphsリストに追加 morphs.append(Morph(line)) sentences.append(Sentence(chunks)) # Sentenceを適用しsentencesリストに追加 # 確認 for chunk in sentences[7].chunks: print([morph.surface for morph in chunk.morphs], chunk.dst, chunk.srcs)出力['吾輩', 'は'] 5 [] ['ここ', 'で'] 2 [] ['始め', 'て'] 3 [1] ['人間', 'という'] 4 [2] ['もの', 'を'] 5 [3] ['見', 'た', '。'] -1 [0, 4]42. 係り元と係り先の文節の表示

係り元の文節と係り先の文節のテキストをタブ区切り形式ですべて抽出せよ.ただし,句読点などの記号は出力しないようにせよ.

以降、特に指示がない限り、41と同様に8文目の文で出力を確認しています。

sentence = sentences[7] for chunk in sentence.chunks: if int(chunk.dst) != -1: modifier = ''.join([morph.surface if morph.pos != '記号' else '' for morph in chunk.morphs]) modifiee = ''.join([morph.surface if morph.pos != '記号' else '' for morph in sentence.chunks[int(chunk.dst)].morphs]) print(modifier, modifiee, sep='\t')出力吾輩は 見た ここで 始めて 始めて 人間という 人間という ものを ものを 見た43. 名詞を含む文節が動詞を含む文節に係るものを抽出

名詞を含む文節が,動詞を含む文節に係るとき,これらをタブ区切り形式で抽出せよ.ただし,句読点などの記号は出力しないようにせよ.

sentence = sentences[7] for chunk in sentence.chunks: if int(chunk.dst) != -1: modifier = ''.join([morph.surface if morph.pos != '記号' else '' for morph in chunk.morphs]) modifier_pos = [morph.pos for morph in chunk.morphs] modifiee = ''.join([morph.surface if morph.pos != '記号' else '' for morph in sentence.chunks[int(chunk.dst)].morphs]) modifiee_pos = [morph.pos for morph in sentence.chunks[int(chunk.dst)].morphs] if '名詞' in modifier_pos and '動詞' in modifiee_pos: print(modifier, modifiee, sep='\t')出力吾輩は 見た ここで 始めて ものを 見た44. 係り受け木の可視化

与えられた文の係り受け木を有向グラフとして可視化せよ.可視化には,係り受け木をDOT言語に変換し,Graphvizを用いるとよい.また,Pythonから有向グラフを直接的に可視化するには,pydotを使うとよい.

係り元と係り先の文節のペアを作成し、pydotの

graph_from_edgesに渡すことで、グラフを作成しています。

なお、表層形そのままでは1文内に同じ文字列の文節が複数回出てきた場合に区別できないため、末尾にIDを付与して表示しています。# 日本語表示用フォントのインストール !apt install fonts-ipafont-gothicimport pydot from IPython.display import Image,display_png from graphviz import Digraph sentence = sentences[7] edges = [] for id, chunk in enumerate(sentence.chunks): if int(chunk.dst) != -1: modifier = ''.join([morph.surface if morph.pos != '記号' else '' for morph in chunk.morphs] + ['(' + str(id) + ')']) modifiee = ''.join([morph.surface if morph.pos != '記号' else '' for morph in sentence.chunks[int(chunk.dst)].morphs] + ['(' + str(chunk.dst) + ')']) edges.append([modifier, modifiee]) n = pydot.Node('node') n.fontname = 'IPAGothic' g = pydot.graph_from_edges(edges, directed=True) g.add_node(n) g.write_png('./ans44.png') display_png(Image('./ans44.png'))45. 動詞の格パターンの抽出

今回用いている文章をコーパスと見なし,日本語の述語が取りうる格を調査したい. 動詞を述語,動詞に係っている文節の助詞を格と考え,述語と格をタブ区切り形式で出力せよ. ただし,出力は以下の仕様を満たすようにせよ.

- 動詞を含む文節において,最左の動詞の基本形を述語とする

- 述語に係る助詞を格とする

- 述語に係る助詞(文節)が複数あるときは,すべての助詞をスペース区切りで辞書順に並べる

このプログラムの出力をファイルに保存し,以下の事項をUNIXコマンドを用いて確認せよ.

- コーパス中で頻出する述語と格パターンの組み合わせ

- 「する」「見る」「与える」という動詞の格パターン(コーパス中で出現頻度の高い順に並べよ)

with open('./ans45.txt', 'w') as f: for sentence in sentences: for chunk in sentence.chunks: for morph in chunk.morphs: if morph.pos == '動詞': # chunkの左から順番に動詞を探す cases = [] for src in chunk.srcs: # 見つけた動詞の係り元chunkから助詞を探す cases = cases + [morph.surface for morph in sentence.chunks[src].morphs if morph.pos == '助詞'] if len(cases) > 0: # 助詞が見つかった場合は辞書順にソートして出力 cases.sort() line = '{}\t{}'.format(morph.base, ' '.join(cases)) print(line, file=f) break# 確認 !cat ./ans45.txt | sort | uniq -c | sort -nr | head -n 10出力2414 ある が 1395 つく か が 676 云う に 608 する が で と 330 つかむ を 319 見る の 270 思う と 260 云う と は 238 かかる が て 237 かく たり を!cat ./ans45.txt | grep 'する' | sort | uniq -c | sort -nr | head -n 5出力1128 する が 729 する が と 311 する が で と 130 する と は は は 126 する でも に!cat ./ans45.txt | grep '見る' | sort | uniq -c | sort -nr | head -n 5出力319 見る の 113 見る は を 50 見る て て は 23 見る から て 22 見る から!cat ./ans45.txt | grep '与える' | sort | uniq -c | sort -nr | head -n 5出力5 与える ば を 3 与える け に を 2 与える だけ で に を 2 与える て に は を 1 与える に に対して のみ は は も46. 動詞の格フレーム情報の抽出

45のプログラムを改変し,述語と格パターンに続けて項(述語に係っている文節そのもの)をタブ区切り形式で出力せよ.45の仕様に加えて,以下の仕様を満たすようにせよ.

- 項は述語に係っている文節の単語列とする(末尾の助詞を取り除く必要はない)

- 述語に係る文節が複数あるときは,助詞と同一の基準・順序でスペース区切りで並べる

with open('./ans46.txt', 'w') as f: for sentence in sentences: for chunk in sentence.chunks: for morph in chunk.morphs: if morph.pos == '動詞': # chunkの左から順番に動詞を探す cases = [] modi_chunks = [] for src in chunk.srcs: # 見つけた動詞の係り元chunkから助詞を探す case = [morph.surface for morph in sentence.chunks[src].morphs if morph.pos == '助詞'] if len(case) > 0: # 助詞を含むchunkの場合は助詞と項を取得 cases = cases + case modi_chunks.append(''.join(morph.surface for morph in sentence.chunks[src].morphs if morph.pos != '記号')) if len(cases) > 0: # 助詞が1つ以上見つかった場合は辞書順にソートし、項と合わせて出力 cases.sort() line = '{}\t{}\t{}'.format(morph.base, ' '.join(cases), ' '.join(modi_chunks)) print(line, file=f) break# 確認 !cat ./ans46.txt | head -n 10出力生れる で どこで つく か が 生れたか 見当が 泣く で 所で する だけ て は 泣いて いた事だけは 始める で ここで 見る は を 吾輩は ものを 聞く で あとで 捕える を 我々を 煮る て 捕えて 食う て 煮て47. 機能動詞構文のマイニング

動詞のヲ格にサ変接続名詞が入っている場合のみに着目したい.46のプログラムを以下の仕様を満たすように改変せよ.

- 「サ変接続名詞+を(助詞)」で構成される文節が動詞に係る場合のみを対象とする 述語は「サ変接続名詞+を+動詞の基本形」とし,文節中に複数の動詞があるときは,最左の動詞を用いる

- 述語に係る助詞(文節)が複数あるときは,すべての助詞をスペース区切りで辞書順に並べる

- 述語に係る文節が複数ある場合は,すべての項をスペース区切りで並べる(助詞の並び順と揃えよ)

このプログラムの出力をファイルに保存し,以下の事項をUNIXコマンドを用いて確認せよ.

- コーパス中で頻出する述語(サ変接続名詞+を+動詞)

- コーパス中で頻出する述語と助詞パターン

with open('./ans47.txt', 'w') as f: for sentence in sentences: for chunk in sentence.chunks: for morph in chunk.morphs: if morph.pos == '動詞': # chunkの左から順番に動詞を探す for i, src in enumerate(chunk.srcs): # 見つけた動詞の係り元chunkが「サ変接続名詞+を」で構成されるか確認 if len(sentence.chunks[src].morphs) == 2 and sentence.chunks[src].morphs[0].pos1 == 'サ変接続' and sentence.chunks[src].morphs[1].surface == 'を': predicate = ''.join([sentence.chunks[src].morphs[0].surface, sentence.chunks[src].morphs[1].surface, morph.base]) cases = [] modi_chunks = [] for src_r in chunk.srcs[:i] + chunk.srcs[i + 1:]: # 残りの係り元chunkから助詞を探す case = [morph.surface for morph in sentence.chunks[src_r].morphs if morph.pos == '助詞'] if len(case) > 0: # 助詞を含むchunkの場合は助詞と項を取得 cases = cases + case modi_chunks.append(''.join(morph.surface for morph in sentence.chunks[src_r].morphs if morph.pos != '記号')) if len(cases) > 0: # 助詞が1つ以上見つかった場合は辞書順にソートし、項と合わせて出力 cases.sort() line = '{}\t{}\t{}'.format(predicate, ' '.join(cases), ' '.join(modi_chunks)) print(line, file=f) break# 確認 !cat ./ans47.txt | cut -f 1 | sort | uniq -c | sort -nr | head -n 10出力29 返事をする 21 挨拶をする 18 話をする 9 質問をする 8 昼寝をする 8 喧嘩をする 7 真似をする 7 問答をやる 6 相談をする 5 質問をかける!cat ./ans47.txt | cut -f 1,2 | sort | uniq -c | sort -nr | head -n 10出力8 返事をする と よ 8 返事をする て 6 話をする か は 6 話をする に 6 挨拶をする で 5 昼寝をする が 5 挨拶をする から 5 挨拶をする か と も 5 喧嘩をする で 4 返事をする さ と に は48. 名詞から根へのパスの抽出

文中のすべての名詞を含む文節に対し,その文節から構文木の根に至るパスを抽出せよ. ただし,構文木上のパスは以下の仕様を満たすものとする.

- 各文節は(表層形の)形態素列で表現する

- パスの開始文節から終了文節に至るまで,各文節の表現を” -> “で連結する

sentence = sentences[7] for chunk in sentence.chunks: if '名詞' in [morph.pos for morph in chunk.morphs]: # chunkが名詞を含むか確認 path = [''.join(morph.surface for morph in chunk.morphs if morph.pos != '記号')] while chunk.dst != -1: # 名詞を含むchunkを先頭に、dstを根まで順に辿ってリストに追加 path.append(''.join(morph.surface for morph in sentence.chunks[chunk.dst].morphs if morph.pos != '記号')) chunk = sentence.chunks[chunk.dst] print(' -> '.join(path))出力吾輩は -> 見た ここで -> 始めて -> 人間という -> ものを -> 見た 人間という -> ものを -> 見た ものを -> 見た49. 名詞間の係り受けパスの抽出

文中のすべての名詞句のペアを結ぶ最短係り受けパスを抽出せよ.ただし,名詞句ペアの文節番号がiとj(i<j)のとき,係り受けパスは以下の仕様を満たすものとする.

- 問題48と同様に,パスは開始文節から終了文節に至るまでの各文節の表現(表層形の形態素列)を” -> “で連結して表現する

- 文節iとjに含まれる名詞句はそれぞれ,XとYに置換する

また,係り受けパスの形状は,以下の2通りが考えられる.

- 文節iから構文木の根に至る経路上に文節jが存在する場合: 文節iから文節jのパスを表示

- 上記以外で,文節iと文節jから構文木の根に至る経路上で共通の文節kで交わる場合: 文節iから文節kに至る直前のパスと文節jから文節kに至る直前までのパス,文節kの内容を” | “で連結して表示

例えば、

i -> a -> b -> j -> 根であれば、i -> a -> b -> ji -> a -> k -> 根、j -> b -> k -> 根であれば、i -> a | j -> b | kとし、i、jの名詞をそれぞれX、Yに変換して表示すればよいことになります。

from itertools import combinations sentence = sentences[7] nouns = [] for i, chunk in enumerate(sentence.chunks): if '名詞' in [morph.pos for morph in chunk.morphs]: # 名詞を含む文節を抽出 nouns.append(i) for i, j in combinations(nouns, 2): # 名詞を含む文節のペアごとにパスを作成 path_i = [] path_j = [] while i != j: # i, jが同じ文節に到達するまでdstを順に辿る if i < j: path_i.append(i) i = sentence.chunks[i].dst else: path_j.append(j) j = sentence.chunks[j].dst if len(path_j) == 0: # 1つ目のケース chunk_X = ''.join([morph.surface if morph.pos != '名詞' else 'X' for morph in sentence.chunks[path_i[0]].morphs]) chunk_Y = ''.join([morph.surface if morph.pos != '名詞' else 'Y' for morph in sentence.chunks[i].morphs]) path_XtoY = [chunk_X] + [''.join(morph.surface for morph in sentence.chunks[n].morphs) for n in path_i[1:]] + [chunk_Y] print(' -> '.join(path_XtoY)) else: # 2つ目のケース chunk_X = ''.join([morph.surface if morph.pos != '名詞' else 'X' for morph in sentence.chunks[path_i[0]].morphs]) chunk_Y = ''.join([morph.surface if morph.pos != '名詞' else 'Y' for morph in sentence.chunks[path_j[0]].morphs]) chunk_k = ''.join([morph.surface for morph in sentence.chunks[i].morphs]) path_X = [chunk_X] + [''.join(morph.surface for morph in sentence.chunks[n].morphs) for n in path_i[1:]] path_Y = [chunk_Y] + [''.join(morph.surface for morph in sentence.chunks[n].morphs) for n in path_j[1:]] print(' | '.join([' -> '.join(path_X), ' -> '.join(path_Y), chunk_k]))出力Xは | Yで -> 始めて -> 人間という -> ものを | 見た。 Xは | Yという -> ものを | 見た。 Xは | Yを | 見た。 Xで -> 始めて -> Yという Xで -> 始めて -> 人間という -> Yを Xという -> Yをおわりに

言語処理100本ノックは自然言語処理そのものだけでなく、基本的なデータ処理や汎用的な機械学習についてもしっかり学ぶことができるように作られています。

オンラインコースなどで機械学習を勉強中の方も、とても良いアウトプットの練習になると思いますので、ぜひ挑戦してみてください。

- 投稿日:2020-05-27T22:17:28+09:00

Qt for Python アプリの自己アップデート

備忘録かつ添削をお願いしたく。

パッケージ化しないアプリでも、アップデートする仕組みを入れておかないと、修正する度にそれぞれのマシンでコピーする作業が起こってしまう事に気が付きました。

http経由でダウンロードする事も、zipファイルを展開することも簡単にできてしまうのだから、それを組み合わせてアプリケーションディレクトリのの .py ファイルを更新してやればよいのでは?ということで、当該の部分はこのようになりました。def updateDownloadQuit(self): url ="http://〜〜" title = './update.zip' urllib.request.urlretrieve(url,"{0}".format(title)) QMessageBox.information(None, "Info", "アプリケーションを更新して、終了します") with zipfile.ZipFile('update.zip') as existing_zip: existing_zip.extractall('.') MainWindow.close()Qtでなくても、ちょっとしたスクリプト群の配布に使えると思います。

- 投稿日:2020-05-27T22:16:44+09:00

Python 備忘録(個人的ブックマーク)

多分、ゴミ投稿…

逐次、更新。

覚書

商と余り

q = 10 // 3 # 商 mod = 10 % 3 # 余り q, mod = divmod(10, 3) # 商と余りを同時にswap

a, b = b, aもう tmp 要らない…。

ユークリッドの互除法 Python 版

def gcd(a, n): if n == 0: return a else: return gcd(n, a % n)つか、標準ライブラリ等がありますね。

- math.gcd(a, b) — math --- 数学関数 — Python 3.8.3 ドキュメント ※バージョン 3.5 で追加

- numpy.gcd — NumPy v1.18 Manual

- numpy.lcm — NumPy v1.18 Manual

- Pythonで最大公約数と最小公倍数を算出・取得 | note.nkmk.me

- NumPyで最大公約数・最小公倍数を算出・取得 | note.nkmk.me

Windows でのトラブル

Python をインストールせずにショートカットを無効にするには、[スタート] から Manage app execution aliases を開き、"App Installer" (アプリ インストーラー) Python エントリを見つけて "オフ" に切り替えます。

Python 公式等

Anaconda 関連

- Anaconda | The World's Most Popular Data Science Platform

- conda-forgeからのPythonパッケージインストール - われがわログ

- AnacondaによるPython 3.6環境構築と環境管理 | 東京大学 佐々木淳 研究室 沿岸環境学 海岸工学 環境水工学 水環境学

Python 仮想環境

- venv --- 仮想環境の作成 — Python 3.8.3 ドキュメント

- Virtualenv

- virtualenv cloning script.

- Pipenv: Python Development Workflow for Humans

科学技術計算・統計

公式

- NumPy

- pandas - Python Data Analysis Library

- Matplotlib: Python plotting — Matplotlib 3.2.1 documentation

- SymPy

- SciPy.org — SciPy.org

日本語での解説

GIS

- ArcGIS API for Python | ArcGIS for Developers

- GIS奮闘記

- Python 経度・緯度で与えられた2点間距離計算 - Qiita

- Folium: Python で地図可視化 - Tak's Notebook

機械学習

- TensorFlow

- Keras: the Python deep learning API

- scikit-learn: machine learning in Python — scikit-learn 0.23.1 documentation

- PyTorch

形態素解析

Web フレームワーク

- The Web framework for perfectionists with deadlines | Django

- Home - Django REST framework

- Flask | The Pallets Projects

番外編

画像処理

OCR

Excel 操作

Game

その他

- 投稿日:2020-05-27T21:31:53+09:00

グラフ描画ライブラリBokehの使い方

・ツールチップでデータの中身を確認することが可能

import matplotlib.pyplot as plt import numpy as np import random from bokeh.io import output_notebook, show from bokeh.plotting import figure,show output_notebook() x = np.linspace(1, 10, 10) y = [random.randint(0, 10) for i in range(10)] TOOLTIPS = [ ("index", "$index"), ("(x,y)", "($x, $y)"), ] #グラフ設定 p = figure(tooltips=TOOLTIPS, title="グラフタイトル", x_axis_label="x軸", y_axis_label="y軸") # 散布図 p.circle(x = x,y = y) #show(p) # 折れ線グラフ #p.line(x = x,y = y) #show(p) # 棒グラフ #p.vbar(x = x,top = y,width=0.5) show(p)

- 投稿日:2020-05-27T21:20:50+09:00

【PyTorchチュートリアル⑤】Learning PyTorch with Examples (前編)

はじめに

前回に引き続き、PyTorch 公式チュートリアル の第5弾です。

今回は Learning PyTorch with Examples を進めます。Learning PyTorch with Examples

このチュートリアルでは、サンプルコードを通じてPyTorchの2つの主な機能を紹介します。

- Tensor

- 自動微分とニューラルネットワーク

サンプルコードで扱うネットワーク(モデル)は3層(入力層、隠れ層 × 1、出力層)です。

活性化関数は ReLU を使用します。1. Tensor

1.1. Warm-up: numpy

PyTorch の前に、まずは numpy を使用してネットワークを実装します。

Numpy には、ディープラーニング、勾配についての機能はありませんが、

手動で実装することで、簡単なニューラルネットワークを構築できます。import numpy as np # N : バッチサイズ # D_in : 入力次元数 # H : 隠れ層の次元数 # D_out : 出力次元数 N, D_in, H, D_out = 64, 1000, 100, 10 # ランダムな入力データと教師データを作成します x = np.random.randn(N, D_in) y = np.random.randn(N, D_out) # ランダムな値で重みを初期化します w1 = np.random.randn(D_in, H) w2 = np.random.randn(H, D_out) learning_rate = 1e-6 for t in range(500): # 順伝播: 現在の重みの値で、予測値 y を計算します h = x.dot(w1) h_relu = np.maximum(h, 0) y_pred = h_relu.dot(w2) # ロス(損失)を計算し出力します loss = np.square(y_pred - y).sum() print(t, loss) # ロス値を参考に、逆伝播で 重み w1、w2 の勾配を計算します。 grad_y_pred = 2.0 * (y_pred - y) grad_w2 = h_relu.T.dot(grad_y_pred) grad_h_relu = grad_y_pred.dot(w2.T) grad_h = grad_h_relu.copy() grad_h[h < 0] = 0 grad_w1 = x.T.dot(grad_h) # 重みを更新します。 w1 -= learning_rate * grad_w1 w2 -= learning_rate * grad_w2このコードを実行すると、ロス値が減少し、学習が進んでいることが確認できます。

1.2. PyTorch: Tensors

Numpy はGPUを利用して計算することができませんが、PyTorch の Tensor は GPU を利用して数値計算を高速化できます。

Tensor は勾配も計算できますが、ここでは、上記の numpy の例のように、手動で実装してみます。import torch dtype = torch.float device = torch.device("cpu") # device = torch.device("cuda:0") # GPU で実行するにはここのコメントを解除します。 # N : バッチサイズ # D_in : 入力次元数 # H : 隠れ層の次元数 # D_out : 出力次元数 N, D_in, H, D_out = 64, 1000, 100, 10 # ランダムな入力データと教師データを作成します x = torch.randn(N, D_in, device=device, dtype=dtype) y = torch.randn(N, D_out, device=device, dtype=dtype) # ランダムな値で重みを初期化します w1 = torch.randn(D_in, H, device=device, dtype=dtype) w2 = torch.randn(H, D_out, device=device, dtype=dtype) learning_rate = 1e-6 for t in range(500): # 順伝播: 現在の重みの値で、予測値 y を計算します h = x.mm(w1) h_relu = h.clamp(min=0) y_pred = h_relu.mm(w2) # ロス(損失)を計算し出力します loss = (y_pred - y).pow(2).sum().item() if t % 100 == 99: print(t, loss) # ロス値を参考に、逆伝播で 重み w1、w2 の勾配を計算します。 grad_y_pred = 2.0 * (y_pred - y) grad_w2 = h_relu.t().mm(grad_y_pred) grad_h_relu = grad_y_pred.mm(w2.t()) grad_h = grad_h_relu.clone() grad_h[h < 0] = 0 grad_w1 = x.t().mm(grad_h) # 勾配降下法を使用して重みを更新します w1 -= learning_rate * grad_w1 w2 -= learning_rate * grad_w2このコードでも、ロス値が減少し、学習が進んでいることが確認できます。

2. Autograd

2.1. PyTorch: Tensors and autograd

上記の例では、順伝播と逆伝播を手動で実装しましたが、PyTorch の autograd パッケージを利用すると、逆伝播の計算を自動化できます。

・勾配を計算したい変数(Tensor)の requires_grad = True にする

・backward() を実行する

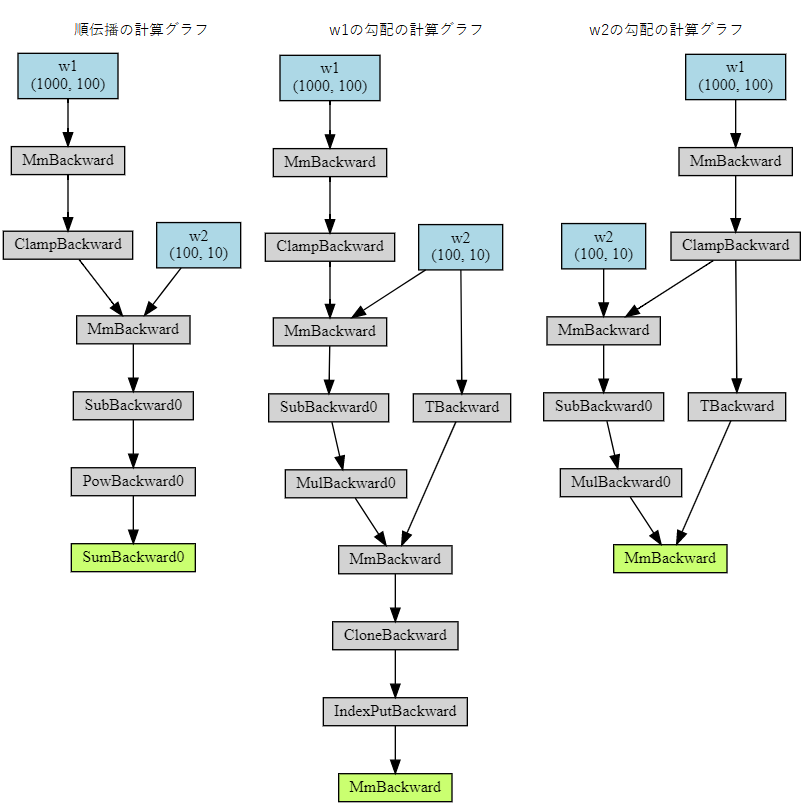

この2つで逆伝播の計算を自動化できます。import torch dtype = torch.float device = torch.device("cpu") # device = torch.device("cuda:0") # GPU で実行するにはここのコメントを解除します。 # N : バッチサイズ # D_in : 入力次元数 # H : 隠れ層の次元数 # D_out : 出力次元数 N, D_in, H, D_out = 64, 1000, 100, 10 # 入力データと教師データを保持するランダムな Tensor を作成します。 # require_grad = False を設定すると、勾配を計算する必要がないことを示します。 x = torch.randn(N, D_in, device=device, dtype=dtype) y = torch.randn(N, D_out, device=device, dtype=dtype) # 重みを保持するランダムな Tensor を作成します。 # requires_grad = True を設定すると、勾配を計算することを示します。 w1 = torch.randn(D_in, H, device=device, dtype=dtype, requires_grad=True) w2 = torch.randn(H, D_out, device=device, dtype=dtype, requires_grad=True) learning_rate = 1e-6 for t in range(500): # 順伝播: Tensor の演算を利用して 予測値 y を計算します # 逆伝播を手動で計算しないため、中間値 h_relu は保持する必要はありません y_pred = x.mm(w1).clamp(min=0).mm(w2) # Tensorの演算を使用して損失を計算、表示します # 損失は形状(1,)のTensorです # loss.item() は損失に保持されているスカラー値を取得します loss = (y_pred - y).pow(2).sum() if t % 100 == 99: print(t, loss.item()) # autogradを使用して、逆伝播を計算します # backward() は、requires_grad = True のすべての Tensor に関する loss の勾配を計算します # この呼び出しの後、w1.grad および w2.grad は、それぞれ w1 , w2 の勾配を保持する Tensor になります loss.backward() # 最急降下法を使用して重みを手動で更新します # 重みには require_grad = True があるため、torch.no_grad() で計算グラフが更新されないようにします # torch.optim.SGD を使用してこの処理と同じことができます with torch.no_grad(): w1 -= learning_rate * w1.grad w2 -= learning_rate * w2.grad # 重みを更新した後、手動で勾配をゼロにします w1.grad.zero_() w2.grad.zero_()チュートリアルにはありませんが、逆伝播の計算グラフを図示してみます。

torchviz を利用することで計算グラフを図示できます。

colaboratory を使用している場合、インストールが必要です。!pip install torchvizPyTorch: Tensors のサンプルコードに少し手を加えます。

ループをやめ、勾配が一度だけ計算されるようにします。# ランダムな入力データと教師データを作成します x = torch.randn(N, D_in, device=device, dtype=dtype) y = torch.randn(N, D_out, device=device, dtype=dtype) # ランダムな値で重みを初期化します w1 = torch.randn(D_in, H, device=device, dtype=dtype, requires_grad=True) w2 = torch.randn(H, D_out, device=device, dtype=dtype, requires_grad=True) # 順伝播: 現在の重みの値で、予測値 y を計算します h = x.mm(w1) h_relu = h.clamp(min=0) y_pred = h_relu.mm(w2) # ロス(損失)を計算し出力します loss = (y_pred - y).pow(2).sum().item() # ロス値を参考に、逆伝播で 重み w1、w2 の勾配を計算します。 grad_y_pred = 2.0 * (y_pred - y) grad_w2 = h_relu.t().mm(grad_y_pred) grad_h_relu = grad_y_pred.mm(w2.t()) grad_h = grad_h_relu.clone() grad_h[h < 0] = 0 grad_w1 = x.t().mm(grad_h)torchviz の make_dot で計算グラフを図にします。

順伝播と勾配を図示します。

param_dict は必須ではありませんが、指定すると図に変数名を記述できます。# 順伝播の計算グラフを図示します。 from torchviz import make_dot param_dict = {'w1': w1, 'w2': w2} make_dot(loss, param_dict) # w1の勾配の計算グラフを図示します。 make_dot(grad_w1, param_dict) # w2の勾配の計算グラフを図示します。 make_dot(grad_w2, param_dict)計算グラフは以下です。

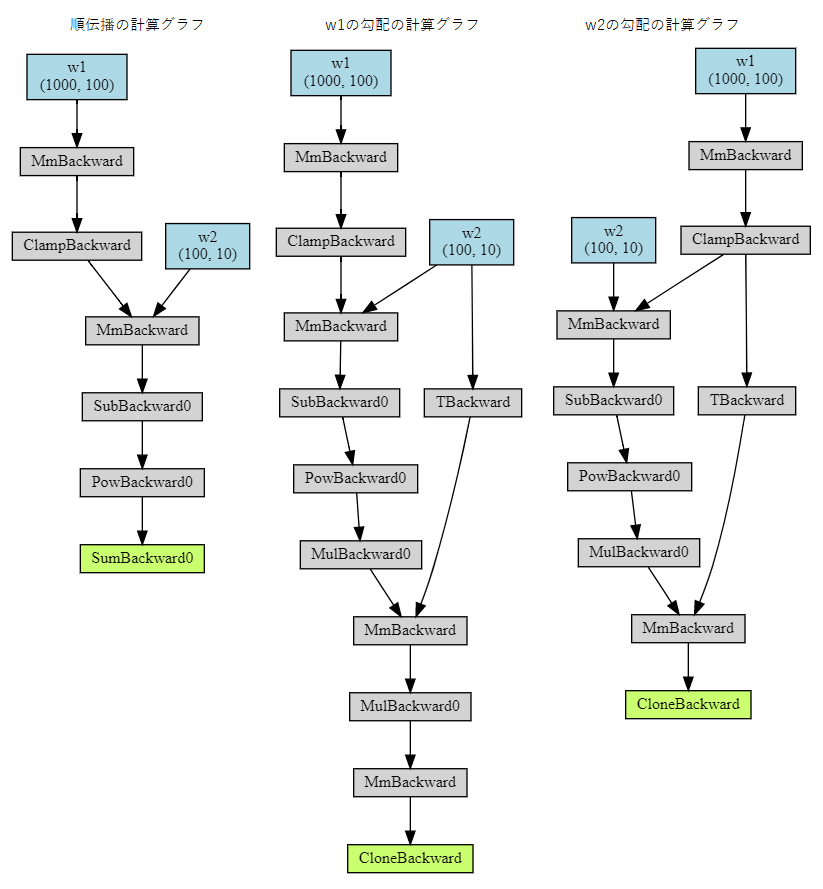

同じように、PyTorch: Tensors and autograd のサンプルコードに手を加え、勾配を一度だけ計算されるようにします。

backward() 実行時に create_graph=True を指定することで導関数のグラフが保持されます。import torch # 入力データと教師データを保持するランダムな Tensor を作成します。 # require_grad = False を設定すると、勾配を計算する必要がないことを示します。 x = torch.randn(N, D_in, device=device, dtype=dtype) y = torch.randn(N, D_out, device=device, dtype=dtype) # 重みを保持するランダムな Tensor を作成します。 # requires_grad = True を設定すると、勾配を計算することを示します。 w1 = torch.randn(D_in, H, device=device, dtype=dtype, requires_grad=True) w2 = torch.randn(H, D_out, device=device, dtype=dtype, requires_grad=True) # 順伝播: Tensor の演算を利用して 予測値 y を計算します # 逆伝播を手動で計算しないため、中間値 h_relu は保持する必要はありません y_pred = x.mm(w1).clamp(min=0).mm(w2) # Tensorの演算を使用して損失を計算、表示します # 損失は形状(1,)のTensorです # loss.item() は損失に保持されているスカラー値を取得します loss = (y_pred - y).pow(2).sum() # autogradを使用して、逆伝播を計算します # backward() は、requires_grad = True のすべての Tensor に関する loss の勾配を計算します # この呼び出しの後、w1.grad および w2.grad は、それぞれ w1 , w2 の勾配を保持する Tensor になります loss_backward = loss.backward(create_graph=True)同じように順伝播と autograd で計算された勾配を図示します。

# 順伝播の計算グラフを図示します。 param_dict = {'w1': w1, 'w2': w2} make_dot(loss, param_dict) # w1の勾配の計算グラフを図示します。 make_dot(w1.grad, param_dict) # w2の勾配の計算グラフを図示します。 make_dot(w2.grad, param_dict)順伝播は同じです。逆伝播は少し形が異なりますが、autograd で逆伝播の計算が自動で行われていることが確認できます。

2.2. PyTorch: Defining new autograd functions

PyTorchでは、torch.autograd.Functionのサブクラスを定義することで、独自の関数(演算子)を定義できます。

サブクラスには、以下の2つ メソッドを実装します。

- forward メソッド:入力 Tensor から出力 Tensor を計算する

- backward メソッド:出力 Tensor の勾配を受け取り、入力 Tensor の勾配を計算する

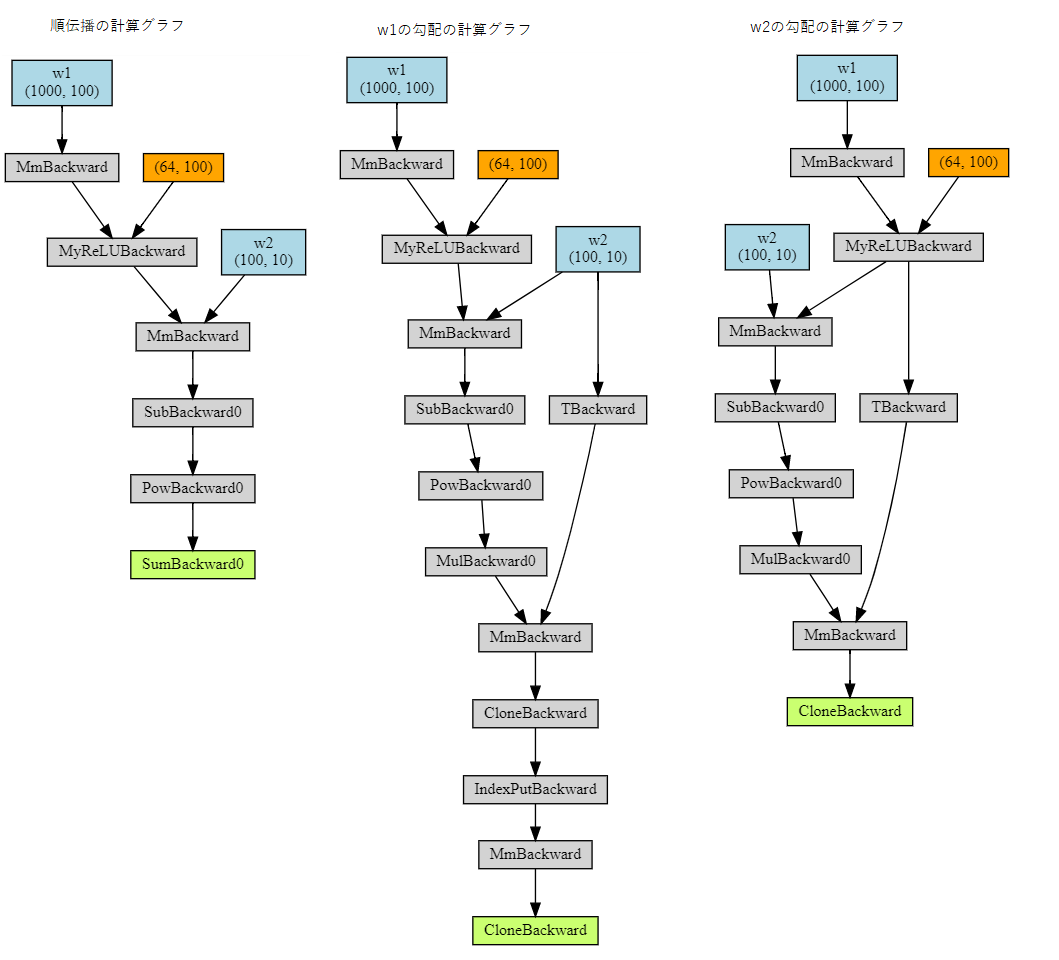

この例では、ReLU関数を意味する独自の関数を用いて、2層ネットワークを定義します。

import torch class MyReLU(torch.autograd.Function): """ torch.autograd.Functionをサブクラス化し、 Tensorsで動作するフォワードパスとバックワードパスを実装することで、 独自のカスタム autograd 関数を実装できます。 """ @staticmethod def forward(ctx, input): """ フォワードパスでは、入力を含むTensorを受け取り、 出力を含むTensorを返します。 ctxは、逆伝播計算のためのオブジェクトです。 ctx.save_for_backwardメソッドを使用して、 オブジェクトをキャッシュできます。 """ ctx.save_for_backward(input) return input.clamp(min=0) @staticmethod def backward(ctx, grad_output): """ backward では、出力に関する損失の勾配を含むTensorを受け取り、 入力に関する損失の勾配を計算する必要があります。 """ input, = ctx.saved_tensors grad_input = grad_output.clone() grad_input[input < 0] = 0 return grad_input dtype = torch.float device = torch.device("cpu") # device = torch.device("cuda:0") # GPU で実行するにはここのコメントを解除します。 # N : バッチサイズ # D_in : 入力次元数 # H : 隠れ層の次元数 # D_out : 出力次元数 N, D_in, H, D_out = 64, 1000, 100, 10 # 入力データと教師データを保持するランダムな Tensor を作成します。 x = torch.randn(N, D_in, device=device, dtype=dtype) y = torch.randn(N, D_out, device=device, dtype=dtype) # 重みを保持するランダムな Tensor を作成します。 w1 = torch.randn(D_in, H, device=device, dtype=dtype, requires_grad=True) w2 = torch.randn(H, D_out, device=device, dtype=dtype, requires_grad=True) learning_rate = 1e-6 for t in range(500): # 関数を適用するには、Function.applyメソッドを使用します。 relu = MyReLU.apply # 順伝播: カスタム autograd 関数を利用して 予測値 y を計算します y_pred = relu(x.mm(w1)).mm(w2) # 損失を計算、表示します loss = (y_pred - y).pow(2).sum() if t % 100 == 99: print(t, loss.item()) # autogradを使用して、逆伝播を計算します loss.backward() # 最急降下法を使用して重みを更新します with torch.no_grad(): w1 -= learning_rate * w1.grad w2 -= learning_rate * w2.grad # 重みを更新した後、手動で勾配をゼロにします w1.grad.zero_() w2.grad.zero_()独自関数も可視化してみます。

先ほどと同様、1回のみ処理されるようにします。# 入力データと教師データを保持するランダムな Tensor を作成します。 x = torch.randn(N, D_in, device=device, dtype=dtype) y = torch.randn(N, D_out, device=device, dtype=dtype) # 重みを保持するランダムな Tensor を作成します。 w1 = torch.randn(D_in, H, device=device, dtype=dtype, requires_grad=True) w2 = torch.randn(H, D_out, device=device, dtype=dtype, requires_grad=True) # 関数を適用するには、Function.applyメソッドを使用します。 relu = MyReLU.apply # 順伝播: カスタム autograd 関数を利用して 予測値 y を計算します y_pred = relu(x.mm(w1)).mm(w2) # 損失を計算、表示します loss = (y_pred - y).pow(2).sum() # autogradを使用して、逆伝播を計算します loss.backward(create_graph=True)だいたい、似たような計算グラフになっているでしょうか。

続く

長くなりましたので、PyTorch: nn は後編に分けたいと思います。

履歴

2020/05/27 初版公開

- 投稿日:2020-05-27T20:58:54+09:00

ノンコーディングで機械学習 AutoMLサービスまとめ

はじめに?

ノンコーディングで機械学習モデルが生成可能なツール、サービスをご紹介します。

GUIツールから、pythonライブラリなど、様々な物を探してみました。そもそもAutoMLって??

機械学習にはそもそも以下のようプロセスがあります。

- 課題定義

- データ収集

- データ調整

- 特徴エンジニアリング

- アルゴリズム選定

- パラメータ調整

- 学習

- 評価

- 推論

このうち3~9の部分を自動的に行ってくれるのがAutoMLツールとなります。

どんなサービスがあるか

大きく分けて以下のカテゴリがあります。

* クラウドサービス

* オープンソースライブラリ

* フリーソフトクラウドサービス?

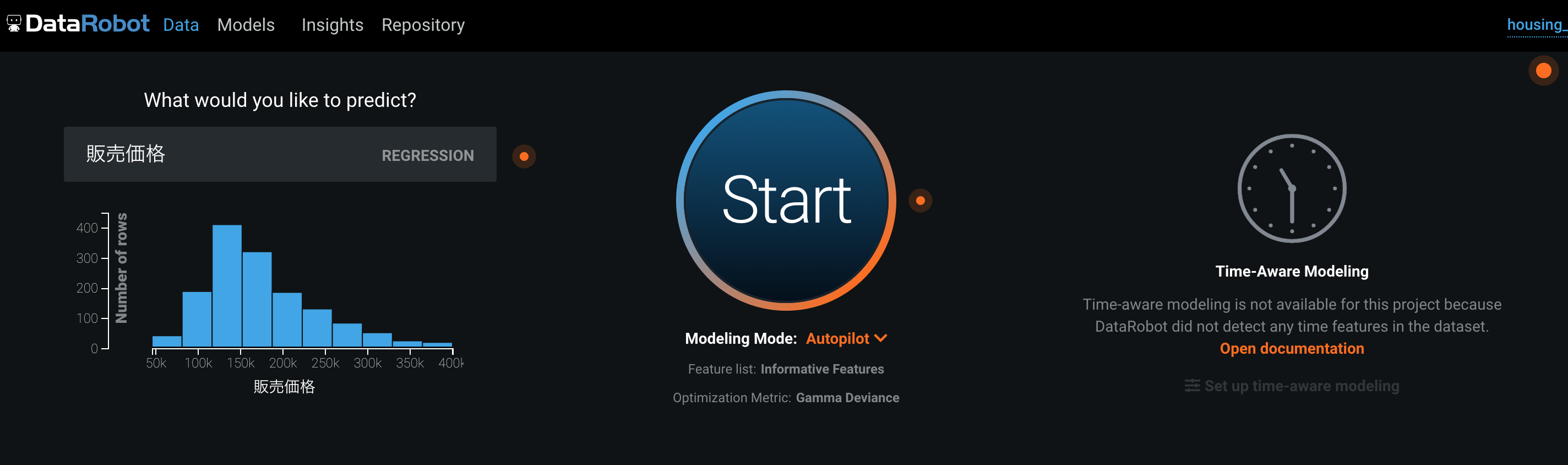

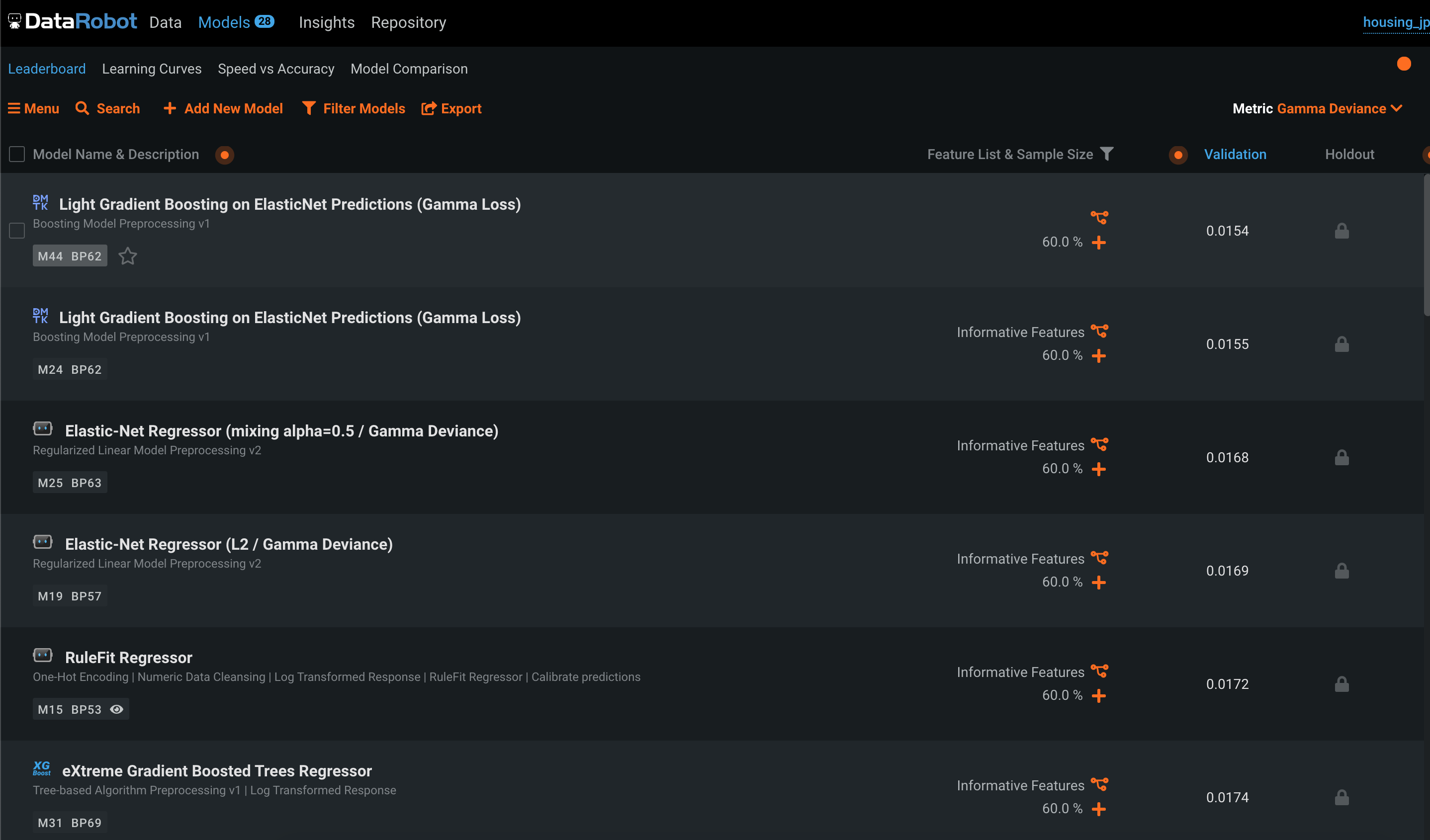

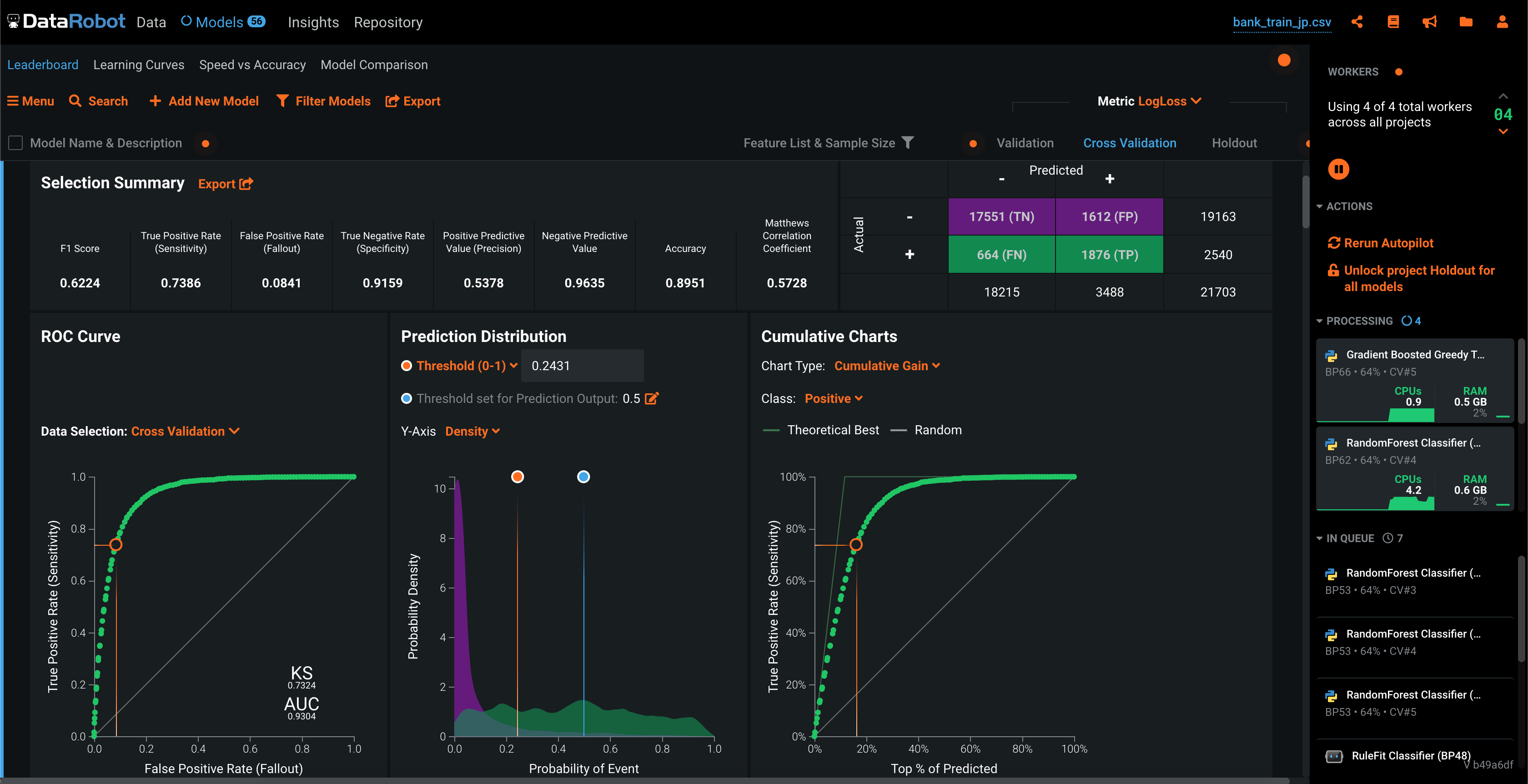

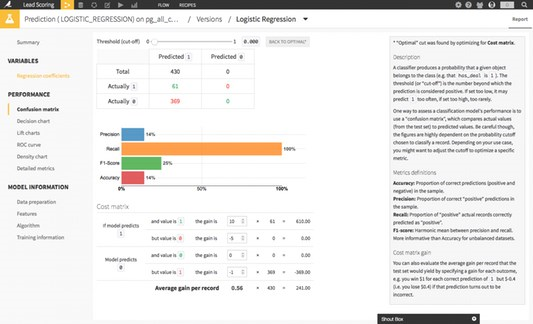

DataRobot

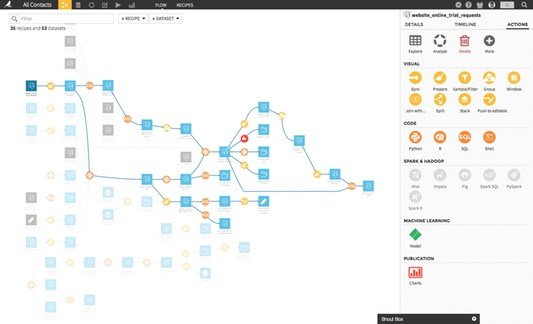

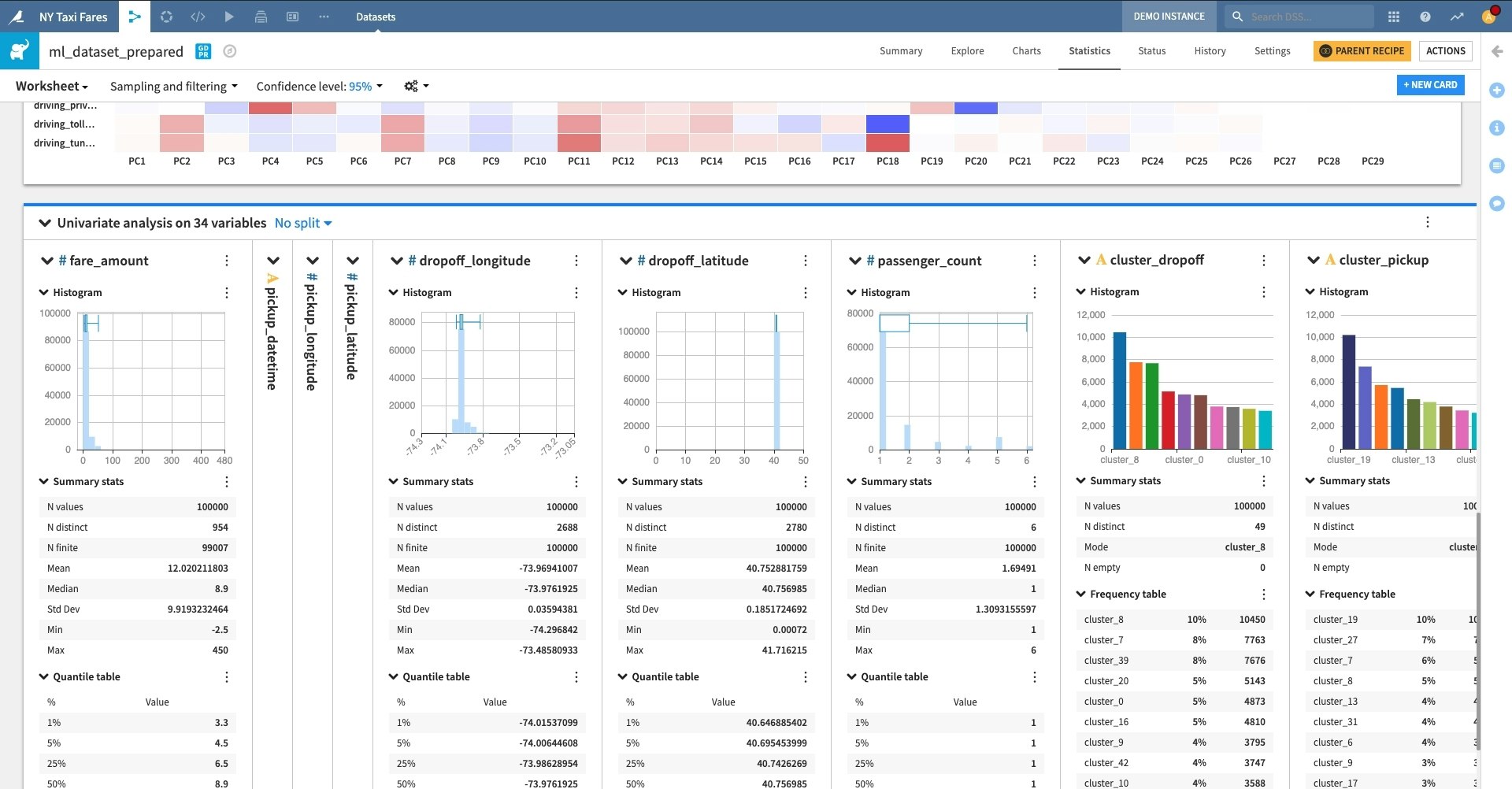

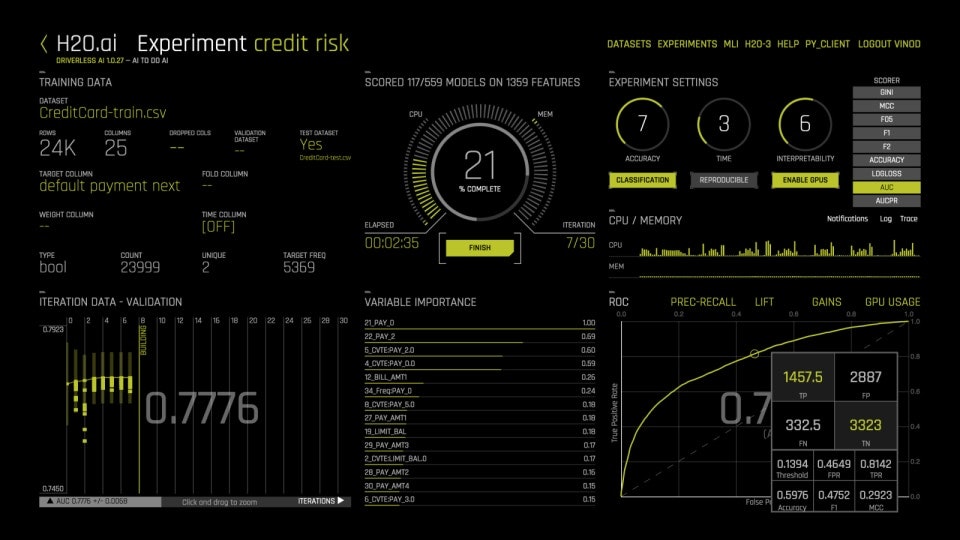

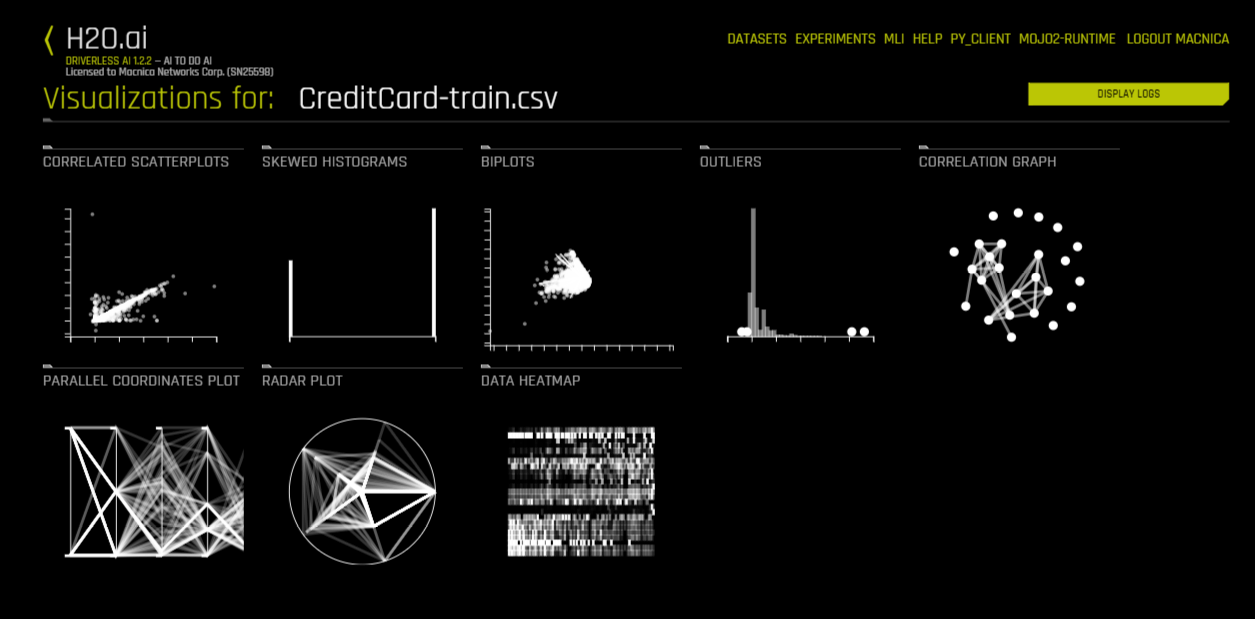

サービス内画面

Dataiku

サービス内画面

H2O DriverlessAI

https://www.h2o.ai/products/h2o-driverless-ai/

サービス内画面

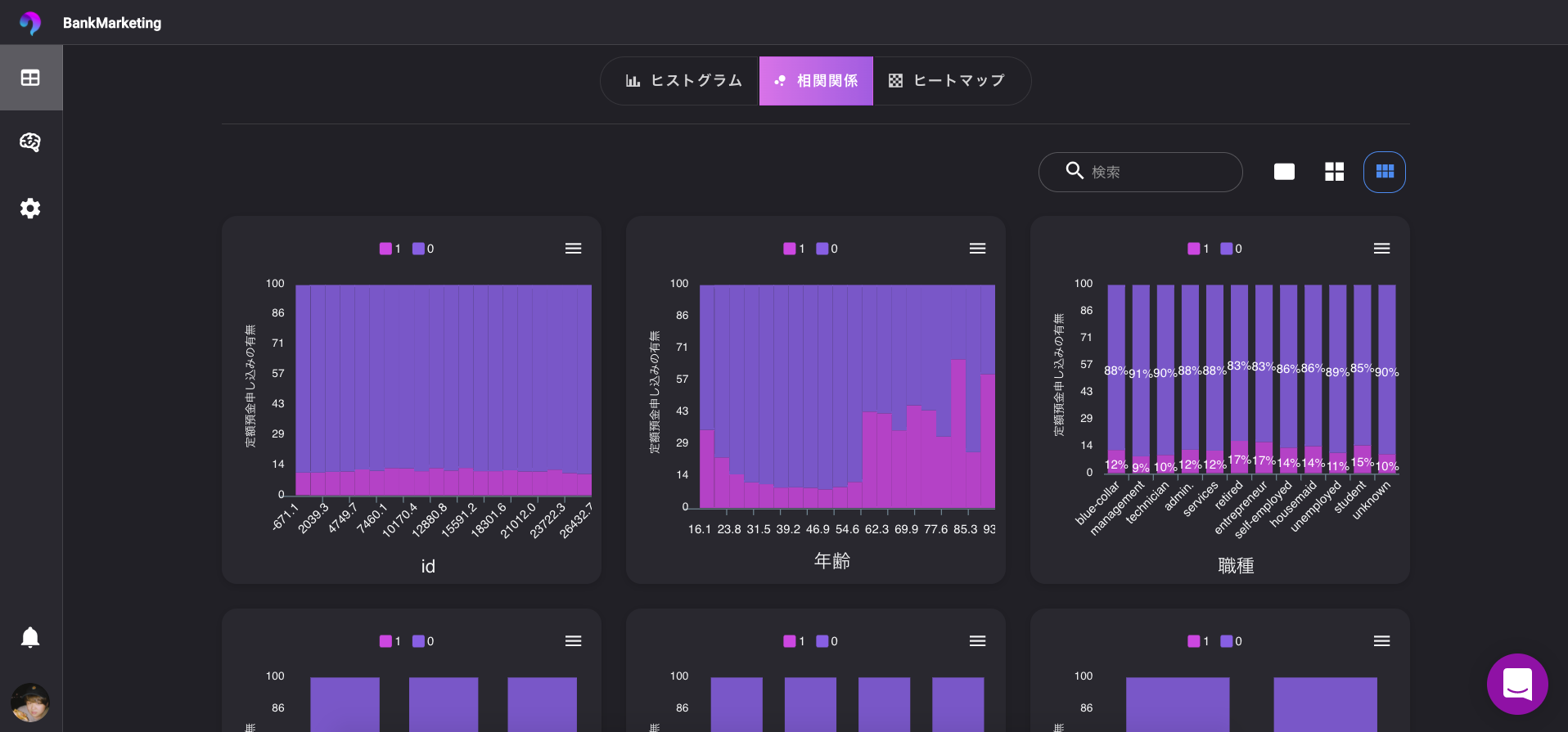

VARISTA

サービス内画面

オープンソースライブラリ

PyCaret

AutoGluon

フリーソフト

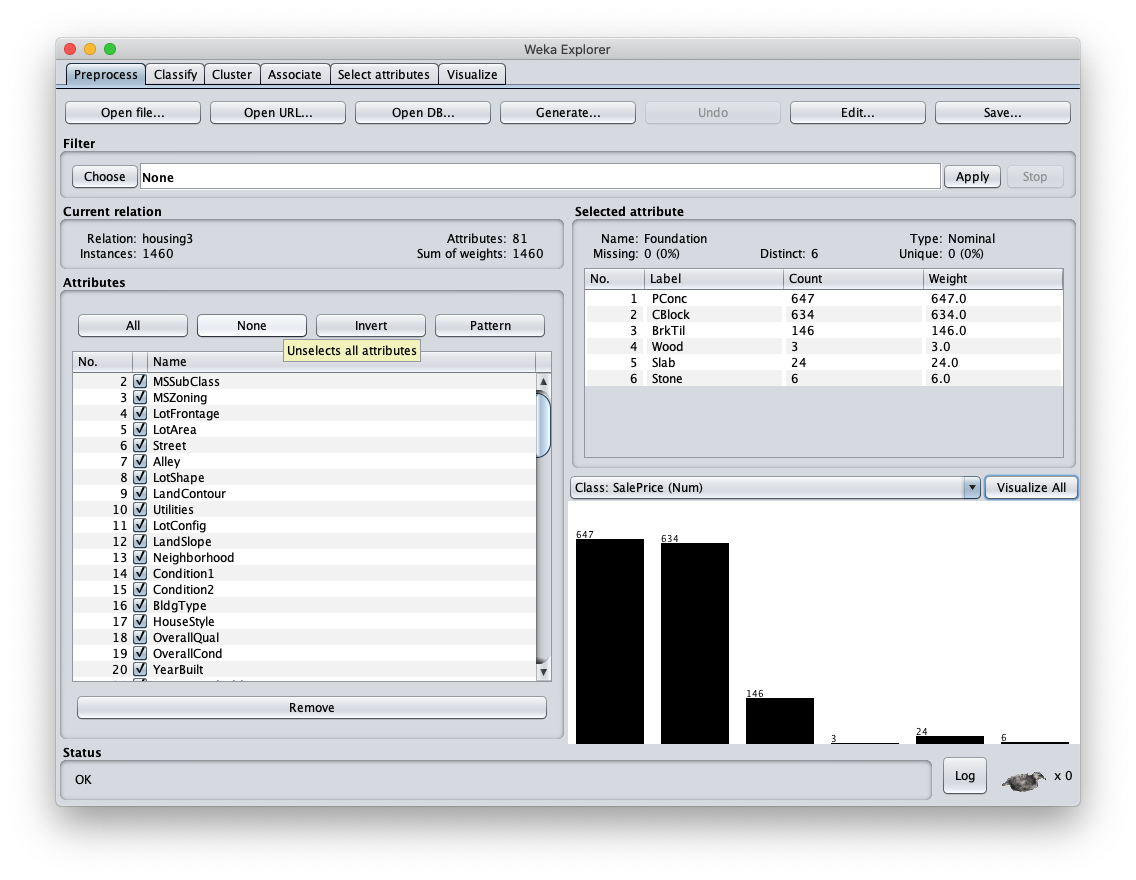

WEKA

https://www.cs.waikato.ac.nz/ml/weka/

おわり?

すてきなAutoMLライフを⭐️

- 投稿日:2020-05-27T19:05:46+09:00

100日後にエンジニアになるキミ - 68日目 - プログラミング - TF-IDFについて

昨日までのはこちら

100日後にエンジニアになるキミ - 66日目 - プログラミング - 自然言語処理について

100日後にエンジニアになるキミ - 63日目 - プログラミング - 確率について1

100日後にエンジニアになるキミ - 59日目 - プログラミング - アルゴリズムについて

100日後にエンジニアになるキミ - 53日目 - Git - Gitについて

100日後にエンジニアになるキミ - 42日目 - クラウド - クラウドサービスについて

100日後にエンジニアになるキミ - 36日目 - データベース - データベースについて

100日後にエンジニアになるキミ - 24日目 - Python - Python言語の基礎1

100日後にエンジニアになるキミ - 18日目 - Javascript - JavaScriptの基礎1

100日後にエンジニアになるキミ - 14日目 - CSS - CSSの基礎1

100日後にエンジニアになるキミ - 6日目 - HTML - HTMLの基礎1

今回はTF-IDFについてです。

TF-IDFとは

TF-IDFは索引語頻度逆文書頻度のことで

TF(Term Frequency)単語の出現頻度と

IDF(Inverse Document Frequency)単語の希少度とを

掛け合わせたものになります。$$

{TF: 文書における指定単語の出現頻度: \frac{文書内の指定単語の出現回数}{文書内の全単語の出現回数}\

}

$$$$

{IDF: 逆文書頻度(指定単語の希少度): log\frac{総文書数}{指定単語を含む文書数}}

$$$$

{TFIDF(索引語頻度逆文書頻度) = TF * IDF}

$$参考:

https://ja.wikipedia.org/wiki/Tf-idfワードカウント

まずは文章の単語数を数えてみましょう。

カウント用の文章を作っておきます。

result_list = [] result_list.append('吾輩 は 猫 で ある') result_list.append('吾輩 は 猫 で ある') result_list.append('吾輩 も です') result_list.append('どうぞ どうぞ 猫 です')以下のようなコードで単語の出現頻度を数える事ができます。

from sklearn.feature_extraction.text import CountVectorizer import numpy as np import pandas as pd import warnings warnings.filterwarnings('ignore') count_vectorizer = CountVectorizer(token_pattern='(?u)\\b\\w+\\b') count_vectorizer.fit(result_list) X = count_vectorizer.transform(result_list) print(len(count_vectorizer.vocabulary_)) print(count_vectorizer.vocabulary_) pd.DataFrame(X.toarray(), columns=count_vectorizer.get_feature_names())8

{'吾輩': 6, 'は': 4, '猫': 7, 'で': 1, 'ある': 0, 'も': 5, 'です': 2, 'どうぞ': 3}

ある で です どうぞ は も 吾輩 猫 0 1 1 0 0 1 0 1 1 1 1 1 0 0 1 0 1 1 2 0 0 1 0 0 1 1 0 3 0 0 1 2 0 0 0 1 各文章で単語が何回登場するかを数える事ができます。

次はTF-IDFを求めてみましょう。

以下のようなコードで求める事ができます。

from sklearn.feature_extraction.text import TfidfVectorizer import warnings import numpy as np import pandas as pd warnings.filterwarnings('ignore') tfidf_vectorizer = TfidfVectorizer(token_pattern='(?u)\\b\\w+\\b') tfidf_vectorizer.fit(result_list) print(len(tfidf_vectorizer.vocabulary_)) print(tfidf_vectorizer.vocabulary_) X = tfidf_vectorizer.fit_transform(result_list) pd.DataFrame(X.toarray(), columns=tfidf_vectorizer.get_feature_names())8

{'吾輩': 6, 'は': 4, '猫': 7, 'で': 1, 'ある': 0, 'も': 5, 'です': 2, 'どうぞ': 3}

ある で です どうぞ は も 吾輩 猫 0 0.481635 0.481635 0 0 0.481635 0 0.389925 0.389925 1 0.481635 0.481635 0 0 0.481635 0 0.389925 0.389925 2 0 0 0.553492 0 0 0.702035 0.4481 0 3 0 0 0.35157 0.891844 0 0 0 0.284626 TF-IDFは0から1の間の数値がでます。

たくさんの文章に出てくるものの値は小さくなります。

1つの文章でたくさん出てくるものは重要なワードだと考えられます。1に近いほど希少性の高いワードであると考えることもできます。

まとめ

文章をベクトル化する手法と、単語の希少性を算出する手法があります。

文章を数値化する事ができるので、いろいろな計算を行う事ができるようになります。こう言った手法は機械学習などでは良く用いられるので

名前とかを抑えておきましょう。君がエンジニアになるまであと32日

作者の情報

乙pyのHP:

http://www.otupy.net/Youtube:

https://www.youtube.com/channel/UCaT7xpeq8n1G_HcJKKSOXMwTwitter:

https://twitter.com/otupython

- 投稿日:2020-05-27T18:43:30+09:00

Pythonで線形代数をやってみた(7)

線形代数

理系大学で絶対に習う線形代数をわかりやすく、かつ論理的にまとめる。ちなみにそれをPythonで実装。たまに、Juliaで実装するかも。。。

・Pythonで動かして学ぶ!あたらしい数学の教科書 -機械学習・深層学習に必要な基礎知識-

・世界基準MIT教科書 ストラング線形代数イントロダクション

を基に線形代数を理解し、pythonで実装。環境

・JupyterNotebook

・言語:Python3, Julia1.4.0固有値と固有ベクトル

固有値と固有ベクトルは人工知能でデータの要約する主成分分析法で用いられる。

固有値、固有ベクトル

正方行列Aを考える。

この行列Aにたいして、A\vec{x}=λ\vec{x}を満たすとき、

λを行列Aの固有値\\ \vec{x}を行列Aの固有ベクトル\\という。

固有方程式

上のような式に対して、ベクトルに影響を及ぼすことのない単位行列Eをかける。

A\vec{x}=λE\vec{x}右辺を移項して整理する

(A-λE)\vec{x} = \vec{0}これは要素がすべて0のベクトルを表す。これに対して、逆行列を考えても零

ベクトルである。

この式を固有方程式***という。固有方程式による固有値、固有ベクトルの求解

(A-λE)\vec{x} = \vec{0}に沿って、

A=\begin{pmatrix}3 & 1\\2 & 4\end{pmatrix}として具体例で行う。

そうすると、det(A-λE)\vec{x} = 0\\ ⇔ det(\begin{pmatrix}3 & 1\\2 & 4\end{pmatrix}-λ\begin{pmatrix}1 & 0\\0 & 1\end{pmatrix})\vec{x} = 0\\ ⇔ det\begin{pmatrix}3-λ & 1\\2 & 4-λ\end{pmatrix} = 0\\ ⇔(λ-2)(λ-5)= 0\\これによって、固有値は2または5になる。

固有値によって固有ベクトルも変わってくるので。2,5のときそれぞれで考える。\vec{x} = \begin{pmatrix}p\\q\end{pmatrix}とおくとき、λ=2で計算すると、

det(A-λE)\vec{x} = 0\\ \begin{align} det(A-λE)\vec{x}&= det(A-2E)\begin{pmatrix}p\\q\end{pmatrix} \\ &=\begin{pmatrix}1 & 1\\2 & 2\end{pmatrix}\begin{pmatrix}p\\q\end{pmatrix}\\ &=\begin{pmatrix}p+q\\2p+2q\end{pmatrix} \\ &= \vec{0} \end{align}これより、p+q = 0であるといえるので、任意の実数tを置いて、xベクトルは

\vec{x}=\begin{pmatrix}t\\-t\end{pmatrix}と固有ベクトルを求められる。

λ=5のときは、

\vec{x}=\begin{pmatrix}t\\2t\end{pmatrix}となる。

プログラム

固有値、固有ベクトルを求めるプログラム

python

7pythoneigenvaluevectorimport numpy as np A = np.array([[3, 1],[2, 4]]) ev = np.linalg.eig(A) print(ev[0]) print(ev[1])[2. 5.] [[-0.70710678 -0.4472136 ] [ 0.70710678 -0.89442719]]ここで

linag.eig関数を使っている。固有値が英語で、eigenvalueというからだ。原理的なプログラムを組もう。今回は固有値までを求める。

python(原理的)

7pythoneigenvaluevector2import numpy as np import sympy #A = [[a, b], # [c, d]] a = int(input()) b = int(input()) c = int(input()) d = int(input()) #=>3 #=>1 #=>2 #=>4 x = sympy.Symbol('x') eigenequa = x**2 - (a + d)*x + (a * d) - (b * c)``` print(eigenequa) # factorization = sympy.factor(eigenequa) # print(factorization) solve = sympy.solve(eigenequa) print(solve) #=>x**2 - 7*x + 10 #=>[2, 5]juliaはものすごい簡単なので、載せときます。

julia

7juliaigenvaluevectorusing LinearAlgebra F = eigen([3 1; 2 4;]) #=>Eigen{Float64,Float64,Array{Float64,2},Array{Float64,1}} #=>values: #=>2-element Array{Float64,1}: #=> 2.0 #=> 5.0 #=>vectors: #=>2×2 Array{Float64,2}: #=> -0.707107 -0.447214 #=> 0.707107 -0.894427たった2行だけ!すごい...

今日はここまで

- 投稿日:2020-05-27T18:23:04+09:00

【Colab】巨大なデータセットをコピーする方法

経緯

PyTorchのDCGANチュートリアルで巨大なデータセット(1GB・22万枚画像くらい)が必要

↓

ローカルのJupyter Labで動かしてみたら学習遅い&メモリ不足

↓

GPUも使えるGoogle Colaboratory(以下Colab)上で学習させてみよう

↓

手を動かしていくうちに問題発生データセットをColabにどうやってコピーしよう?

問題

- ColabってGoogle Driveのファイル参照できるの?

- Colab上でZIPって解凍できるの?

ColabってGoogle Driveのファイル参照できるの?

Google Driveをマウントすることで参照することができます。

ノートブックを新規作成し次のコードを実行する。from google.colab import drive drive.mount('/content/drive')認証コードを生成するリンクが貼られるのでアクセスする。

アカウント選択でColabを利用しているアカウントを選択する。

Google Drive File Streamがアクセスを求めてくるので許可する。

認証コードが発行されるのでコピーして、貼り付けてエンター。Go to this URL in a browser: https://accounts.google.com/o/oauth2/auth?client_id=xxx Enter your authorization code:Colab上でZIPって解凍できるの?

Colab上でunzipコマンドが使えます。

まずはGoogle DriveにデータセットのZIPファイルをアップロードし、Colab上にコピーします。cp "./drive/My Drive/Colab Notebooks/data/celeba/img_align_celeba.zip" "."後はunzipコマンドを使いColab上で解凍します。

!unzip "img_align_celeba.zip"解凍した画像を表示してみる

from PIL import Image Image.open('img_align_celeba/000001.jpg')まとめ

- データセットをGoogle DriveにZIPでアップロードする

- Colab上でGoogle Driveをマウントする

- Colab上にZIPファイルをコピーする

- Colab上でZIPファイルを解凍する

追記

Colabにファイルをアップロードするだけなら次のコードでローカルファイルを選択できます。

ただし、容量が大きなファイルをアップロードしようとするとかなり時間がかかっているように感じます。

本稿のGoogle Drive経由の方が早くアップロードできる気がします。from google.colab import files files.upload()

- 投稿日:2020-05-27T16:54:28+09:00

あなたのおっしゃる「タニモト係数」って、どれのことかしら?

化合物の類似性を語るにあたって、有名な指標に「タニモト係数」があります。ところが、「タニモト係数」とだけしか言わない人がけっこういて、「それだけでは説明不十分ですよね?」って悶々とする機会がけっこうあるわけです。

たとえば次の化合物セットを使いましょう

化合物数は10個です。

smiles = [ 'C1=CC=C2C3CC(CNC3)CN2C1=O', 'CN1c2c(C(N(C)C1=O)=O)[nH0](CC(CO)O)c[nH0]2', 'CN1C2CC(CC1C1C2O1)OC(C(c1ccccc1)CO)=O', 'CN1C2CC(CC1C1C2O1)OC(C(c1cccnc1)CO)=O', # 一つ上の化合物と類似 'CN(C=1C(=O)N(c2ccccc2)N(C1C)C)C', 'CN(C=1C(=O)N(C2CCCCC2)N(C1C)C)C', # 一つ上の化合物と類似 'OCC1C(C(C(C(OCC2C(C(C(C(OC(c3ccccc3)C#N)O2)O)O)O)O1)O)O)O', 'OCc1ccccc1OC1C(C(C(C(CO)O1)O)O)O', 'OCc1cc(N)ccc1OC1C(C(C(C(CO)O1)O)O)O', # 一つ上の化合物と類似 '[nH0]1c(OC)c2c([nH0]cc[nH0]2)[nH0]c1', ]SMILES表記からRDKitで化合物を生成

from rdkit import Chem mols = [Chem.MolFromSmiles(smile) for smile in smiles]Morgan fingerprint (の一種)を生成

from rdkit.Chem import AllChem fps = [AllChem.GetMorganFingerprint(mol, 3, useFeatures=True) for mol in mols]タニモト係数を計算

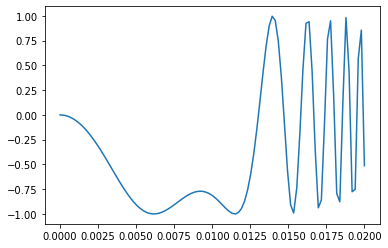

from rdkit import DataStructs sim_matrix = [DataStructs.BulkTanimotoSimilarity(fp, fps) for fp in fps]タニモト係数の分布

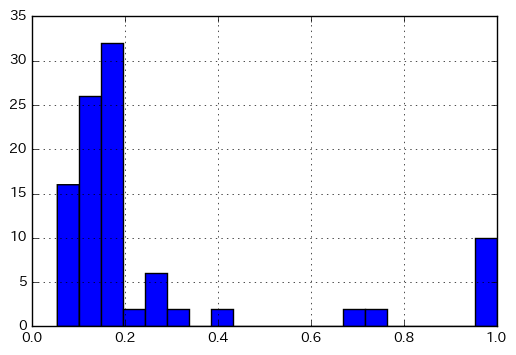

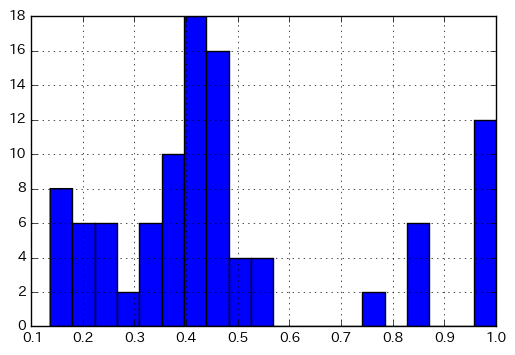

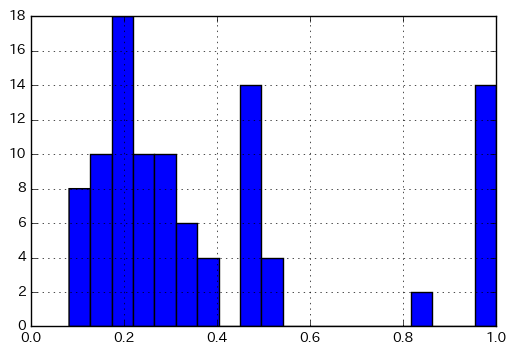

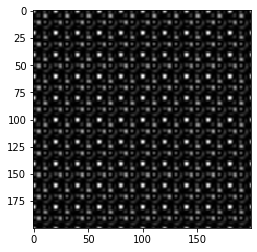

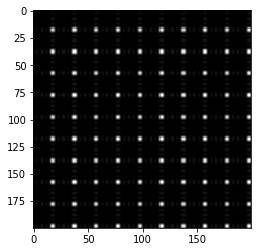

このようにすれば、タニモト係数の分布が見られます。タニモト係数 = 1 のものは同一分子だと思われますが、それ以外でタニモト係数が高めの分子対がありますね。それが何なのか、調べてみてください(あるいは想像してみてください)

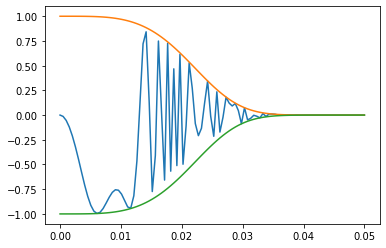

%matplotlib inline import matplotlib.pyplot as plt import numpy as np plt.hist(np.array(sim_matrix).flatten(), bins=20) plt.grid() plt.show()で、Morgan fingerprint にも色々ありまして

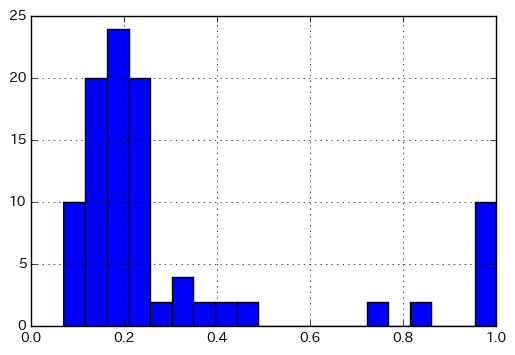

Morgan fingerprintもパラメータがいろいろあって、それを変えるとタニモト係数の数値も変わるわけです。

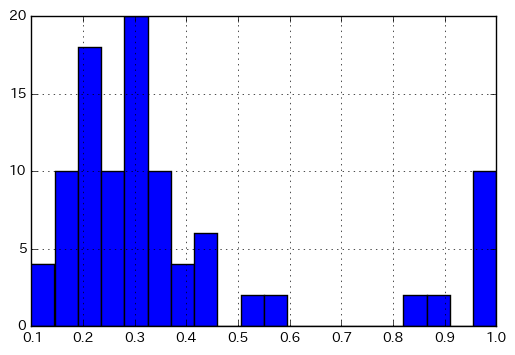

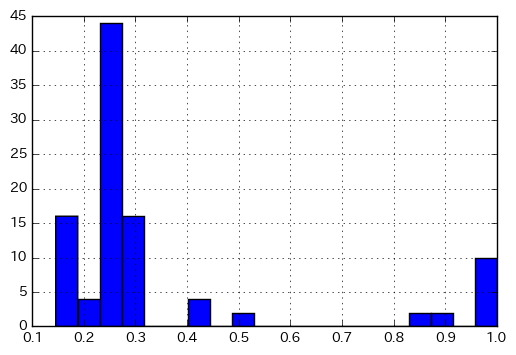

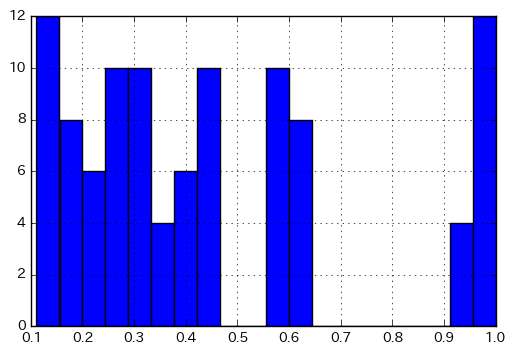

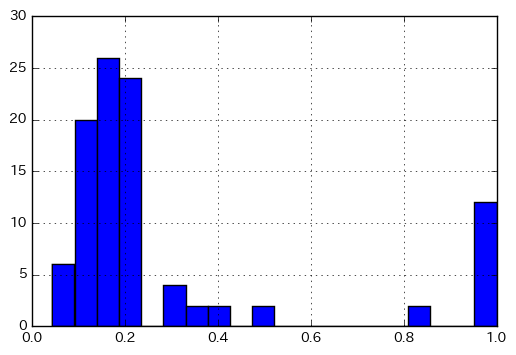

fps = [AllChem.GetMorganFingerprint(mol, 2, useFeatures=True) for mol in mols] sim_matrix = [DataStructs.BulkTanimotoSimilarity(fp, fps) for fp in fps] plt.hist(np.array(sim_matrix).flatten(), bins=20) plt.grid() plt.show()fps = [AllChem.GetMorganFingerprint(mol, 1, useFeatures=True) for mol in mols] sim_matrix = [DataStructs.BulkTanimotoSimilarity(fp, fps) for fp in fps] plt.hist(np.array(sim_matrix).flatten(), bins=20) plt.grid() plt.show()fps = [AllChem.GetMorganFingerprintAsBitVect(mol, 3, 1024) for mol in mols] sim_matrix = [DataStructs.BulkTanimotoSimilarity(fp, fps) for fp in fps] plt.hist(np.array(sim_matrix).flatten(), bins=20) plt.grid() plt.show()fps = [AllChem.GetMorganFingerprintAsBitVect(mol, 3, 2048) for mol in mols] sim_matrix = [DataStructs.BulkTanimotoSimilarity(fp, fps) for fp in fps] plt.hist(np.array(sim_matrix).flatten(), bins=20) plt.grid() plt.show()で、フィンガープリントは他にもありまして

全部計算するのメンドくさいので2つだけ。重要なことの一つとして、下記の計算結果ではタニモト係数が1.0のものが10件以上出てきます。つまり、同一分子でなくてもタニモト係数が1.0になる場合があることは知っておきましょう。

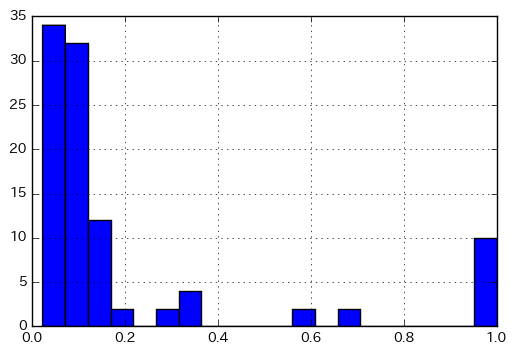

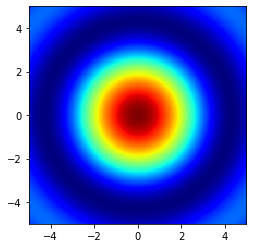

fps = [AllChem.GetMACCSKeysFingerprint(mol) for mol in mols] sim_matrix = [DataStructs.BulkTanimotoSimilarity(fp, fps) for fp in fps] plt.hist(np.array(sim_matrix).flatten(), bins=20) plt.grid() plt.show()fps = [Chem.RDKFingerprint(mol) for mol in mols] sim_matrix = [DataStructs.BulkTanimotoSimilarity(fp, fps) for fp in fps] plt.hist(np.array(sim_matrix).flatten(), bins=20) plt.grid() plt.show()MCSを用いたタニモト係数も定義できるわけでして

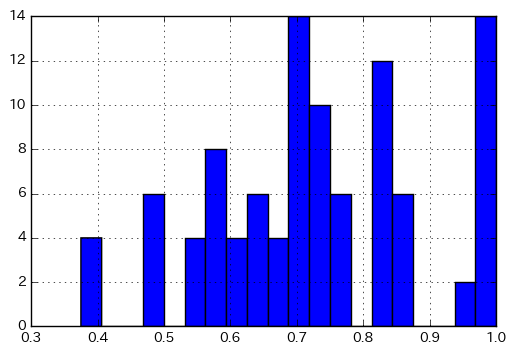

from rdkit.Chem import rdFMCS matrix = [] for mol1 in mols: for mol2 in mols: mcs = rdFMCS.FindMCS([mol1, mol2]) a1 = len(mol1.GetAtoms()) a2 = len(mol2.GetAtoms()) matrix.append(mcs.numAtoms / (a1 + a2 - mcs.numAtoms) ) plt.hist(np.array(matrix).flatten(), bins=20) plt.grid() plt.show()MCSにもいろんなオプションがあるわけでして

from rdkit.Chem import rdFMCS matrix = [] for mol1 in mols: for mol2 in mols: mcs = rdFMCS.FindMCS([mol1, mol2], atomCompare=rdFMCS.AtomCompare.CompareAny) a1 = len(mol1.GetAtoms()) a2 = len(mol2.GetAtoms()) matrix.append(mcs.numAtoms / (a1 + a2 - mcs.numAtoms) ) plt.hist(np.array(matrix).flatten(), bins=20) plt.grid() plt.show()from rdkit.Chem import rdFMCS matrix = [] for mol1 in mols: for mol2 in mols: mcs = rdFMCS.FindMCS([mol1, mol2]) a1 = len(mol1.GetBonds()) a2 = len(mol2.GetBonds()) matrix.append(mcs.numBonds / (a1 + a2 - mcs.numBonds) ) plt.hist(np.array(matrix).flatten(), bins=20) plt.grid() plt.show()from rdkit.Chem import rdFMCS matrix = [] for mol1 in mols: for mol2 in mols: mcs = rdFMCS.FindMCS([mol1, mol2], bondCompare=rdFMCS.BondCompare.CompareOrderExact) a1 = len(mol1.GetBonds()) a2 = len(mol2.GetBonds()) matrix.append(mcs.numBonds / (a1 + a2 - mcs.numBonds) ) plt.hist(np.array(matrix).flatten(), bins=20) plt.grid() plt.show()で、あなたのおっしゃる「タニモト係数」って、どれのことかしら?

- 投稿日:2020-05-27T15:32:23+09:00

Ruby と Python で解く AtCoder ABC130 D 累積和 二分探索

はじめに

AtCoder Problems の Recommendation を利用して、過去の問題を解いています。

AtCoder さん、AtCoder Problems さん、ありがとうございます。今回のお題

AtCoder Beginner Contest D - Enough Array

Difficulty: 859今回のテーマ、累積和 + 二分探索

問題文

(条件)連続部分列に含まれる全ての要素の値の和は、K 以上である。より累積和を使用することが分かりますが、1≦N≦100_000ですので2重にループを回すとTLEになります。

そこで、累積和は単調増加ですので、計算量を抑えるために二分探索も併用します。Ruby

ruby.rbn, k = gets.split.map(&:to_i) a = gets.split.map(&:to_i) acc = 0 x = [0] + a.map{|v| acc += v} cnt = 0 x.each do |y| j = x.bsearch_index{|z| z - y >= k} if j == nil break else cnt += n - j + 1 end end puts cntaccumulate.rbacc = 0 x = [0] + a.map{|v| acc += v}累積和はここで計算しています。

追記

コメントでいただいたコードに修正しました。bsearch.rbj = x.bsearch_index{|z| z - y >= k}二分探索ですが、C++ でいうところの

lower_boundが、Ruby ではbsearch若しくはbsearch_indexになります。Python

python.pyfrom sys import stdin def main(): import bisect import itertools input = stdin.readline n, k = map(int, input().split()) a = list(map(int, input().split())) x = [0] + list(itertools.accumulate(a)) cnt = 0 for z in x: j = bisect.bisect_left(x, k + z) if j <= n: cnt += n - j + 1 print(cnt) main()accumulate.pyx = [0] + list(itertools.accumulate(a))Python では、累積和を求める

accumulateという関数があります。bisect.pyj = bisect.bisect_left(x, k + z)二分探索ですが、

bisect若しくはbisect_leftbisect_rightを使用します。

探索する数値が配列に含まれる場合、bisectはその数値の右側、bisect_leftは左側の位置を返します。for.pyfor z in x: for i in range(n):

range()でループを回すとTLEしました。

Ruby Python コード長 (Byte) 238 377 実行時間 (ms) 165 101 メモリ (KB) 11780 14196 まとめ

- ABC 130 D を解いた

- Ruby に詳しくなった

- Python に詳しくなった

参照したサイト

instance method Array#bsearch

すごいぞitertoolsくん

bisect --- 配列二分法アルゴリズム

- 投稿日:2020-05-27T15:20:44+09:00

Pyppeteerの使い方

Pyppeteerの使い方

目次

Pyppeteerとは

PyppeteerはChromeブラウザを操作するためのPythonパッケージで、node.js用をライブラリPuppeteerをPythonに移植したものです。

Pyppereerの情報は少ないので調べるときはPuppeteerで検索する方がいいかもしれません。インストール

pip install pyppeteer使い方

ブラウザを立ち上げサイトを開く

import asyncio from pyppeteer import launch async def main(): browser = await launch() page = await browser.newPage() await page.goto('https://google.com') if __name__ == "__main__": asyncio.get_event_loop().run_until_complete(main())上記コマンドを実行するとヘッドレスモードでChroniumが起動し、Googleのサイトを開いてブラウザを閉じます。

初回import時に一回だけchromiumがインストールされます。Pyppeteerでは、デフォルトでヘッドレスモードでブラウザが起動します。browser = await launch(headless=False)とする事でブラウザを表示することが出来ます。

要素を取得

# 条件に合った最初の要素を取得 # page.Jでも可能 textbox = await page.querySelector('input[aria-label="検索"]') textbox = await page.J('input[aria-label="検索"]') # 条件に合った全ての要素を取得 # page.JJでも可能 buttons = await page.querySelectorAll('input[aria-label="Google 検索"]') buttons = await page.JJ('input[aria-label="Google 検索"]')テキストボックスに入力する

# page.type(セレクタ, 入力値) # 取得したエレメントからでも可能 await page.type('input[aria-label="検索"]', 'pyppeteer') await textbox.type('pyppeteer')クリックする

# page.click(セレクタ) # 取得した要素からでも可能 # Googleの検索ボタンは2番目の要素を選択しなければならないため # querySelectorAllで取得しなければならない? await page.click('last-child:input[aria-label="Google 検索"]') await buttons[1].click()属性の値を取得する

page.evaluateでjavascriptを実行して取得する。

text = await page.evaluate('elm => elm.getAttribute("name")',textbox)innerHTMLを取得する

上記と同様

elm = await page.J('#hptl') text = await page.evaluate('elm => elm.innerHTML', elm)

- 投稿日:2020-05-27T13:40:57+09:00

【機械学習】標準化すると平均0,標準偏差1になることを数学から理解する

1.目的

機械学習をやってみたいと思った場合、scikit-learn等を使えば誰でも比較的手軽に実装できるようになってきています。

但し、仕事で成果を出そうとしたり、より自分のレベルを上げていくためには

「背景はよくわからないけど何かこの結果になりました」の説明では明らかに弱いことが分かると思います。今回は前処理で登場する「標準化」を取り上げます。

「標準化って聞いたことはあるけどなぜするの?」「scikit-learnではどう使うの?」という前段の説明から、「標準化は”平均0、標準偏差1にするような処理”としかしらないけど、実際にはどのような計算になっているのか、数式から理解したい」という疑問にも答えられるような記事にすることが目的です。

まず2章で標準化の概要を記載し、3章で実際にscikitlearnを使って標準化をしてみます。

最後に4章で、標準化の数式(標準化したら本当に平均0、標準偏差1になるか)について触れたいと思います。※「数学から理解する」シリーズとして、いくつか記事を投稿していますので、併せてお読みいただけますと幸いです。

【機械学習】決定木をscikit-learnと数学の両方から理解する

【機械学習】線形単回帰をscikit-learnと数学の両方から理解する

【機械学習】線形重回帰をscikit-learnと数学の両方から理解する

【機械学習】ロジスティック回帰をscikit-learnと数学の両方から理解する

【機械学習】SVMをscikit-learnと数学の両方から理解する

【機械学習】相関係数はなぜ-1から1の範囲を取るのか、数学から理解する2.標準化とは

(1)標準化とは

結論から言うと、各変数を「平均0、標準偏差1」に収まるように加工する処理のことを言います。

機械学習では前処理でよく使われます。

ざっくり言うと、各データの単位をそろえてあげるイメージです。

例えば売上と気温というデータがあるとき、売上は億単位、気温は最高でも40(℃)くらいとなるとスケールが全然違うので、この2つのデータをそれぞれが平均0、標準偏差1におさまるように変換してあげます。

(具体的には、標準化後は売上0.4、気温0.1という具合です。※数値は適当です)(2)なぜ標準化をするの?

色々な理由があるようですが、その内の1つに「機械学習の多くのアルゴリズムは各変数のスケールが同じであることを前提としている」ことが挙げられます。

例えば先ほど挙げた売上(4億円とする)と気温(35℃とする)の例も、私たち人間は事前に各データが「売上」「気温」であることを知っているため、2つの変数のスケール(単位の規模)が異なっていても違和感なく理解できます。

しかし、コンピュータはそんなことは意識しないため、「400,000,000」と「35」というただの数値と捉え、機械学習において誤った意味付けをしてしまう場合があります。

このような弊害をなくすため、事前に各変数のスケールを合わせる、標準化を行います。

(3)標準化以外にやり方はあるの?

各変数のスケールを合わせる手法は標準化以外にも、正規化という手法があります。

今回は深くは触れないですが、「外れ値の影響を受けにくい」「標準化すると正規分布にもなる」ことから、標準化が行われる場面が多いようです。

3.scikit-learnで標準化

今回も具体例として、いつも利用するkaggleのkickstarter-projectsを例にします。

https://www.kaggle.com/kemical/kickstarter-projectsこの章は長いですが、肝心の標準化は(ⅴ)のみですので、先にそちらを見ていただくのもいいと思います。

(ⅰ)インポート

#numpy,pandasのインポート import numpy as np import pandas as pd #日付データに一部処理を行うため、インポート import datetime #訓練データとテストデータ分割のためにインポート from sklearn.model_selection import train_test_split #標準化のためにインポート from sklearn.preprocessing import StandardScaler #精度検証のためにインポート from sklearn.model_selection import cross_val_score #ロジスティック回帰のためにインポート from sklearn.linear_model import SGDClassifier from sklearn.metrics import log_loss, accuracy_score, confusion_matrix(ⅱ)データの読み込み

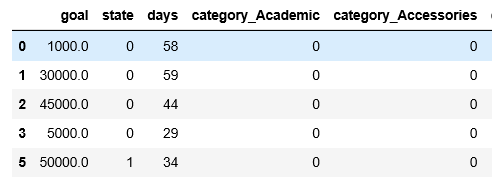

df = pd.read_csv("ks-projects-201801.csv")(ⅲ)データ数の確認

下記より、(378661, 15)のデータセットであることが分かります。

df.shape(ⅳ)データ成形

◆募集日数

詳細は割愛しますが、クラウドファンディングの募集開始時期と終了時期がデータの中にありますので、これを「募集日数」に変換します。

df['deadline'] = pd.to_datetime(df["deadline"]) df["launched"] = pd.to_datetime(df["launched"]) df["days"] = (df["deadline"] - df["launched"]).dt.days◆目的変数について

こちらも詳細は割愛しますが、目的変数である「state」が成功("successful")と失敗("failed")以外にもカテゴリがありますが、今回は成功と失敗のみのデータにします。

df = df[(df["state"] == "successful") | (df["state"] == "failed")]この上で、成功を1、失敗を0に置き換えます。

df["state"] = df["state"].replace("failed",0) df["state"] = df["state"].replace("successful",1)◆不要な行の削除

モデル構築の前に、不要だと思われるidやname(これは本来は残しておくべきかもしれないですが今回は消します)、そしてクラウドファンディングをしてからでないとわからない変数を削除します。

df = df.drop(["ID","name","deadline","launched","backers","pledged","usd pledged","usd_pledged_real","usd_goal_real"], axis=1)◆カテゴリ変数処理

pd.get_dummiesでカテゴリ変数処理を行います。

df = pd.get_dummies(df,drop_first = True)(ⅴ)標準化

いよいよ標準化です。

その前に、現時点のデータをざっと見てみましょう。冒頭の例で挙げたように、「goal(目標金額)」と「days(募集期間)」の単位スケールが結構違うことが分かります。

今回は、この2変数を標準化してみましょう。

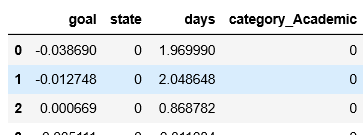

stdsc = StandardScaler() df["goal"] = stdsc.fit_transform(df[["goal"]].values) df["days"] = stdsc.fit_transform(df[["days"]].values)この処理をした上で、再度データを表示してみましょう。

goalとdaysのデータが標準化されました!

(ⅵ)ロジスティック回帰実装

標準化の処理自体は(ⅴ)で終わりですが、一連の流れを把握するという目的で、

ロジスティック回帰モデル構築まで行います。#訓練データとテストデータに分割 y = df["state"].values X = df.drop("state", axis=1).values X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=1234) #ロジスティック回帰モデル構築 clf = SGDClassifier(loss = "log", penalty = "none",random_state=1234) clf.fit(X_train,y_train) #テストデータで精度確認 clf.score(X_test, y_test)これで、精度は0.665と出てきました。

※補足

今回の(ⅴ)標準化がない場合、精度は0.529になりますので、モデル全体の精度が向上していることが分かります。4.標準化を数学から理解する

ここまでは、標準化をとりあえず実装できるようにする目的でscikit-learnを使って標準化を行ってきました。

この章では、標準化が行っている処理を数学の観点から理解していきたいと思います。

(1)標準化の数式

では、ここで具体例を出していきましょう。冒頭に挙げたような、気温と売上の例です。

気温 売上(円) 1 10 400,000,000 2 15 390,000,000 3 30 410,000,000 4 20 405,000,000 5 40 395,000,000 まず結論から出します。

標準化は、下記の数式で求められます。z = \frac{x -u}{σ}よくわからないですね。

$x$は各変数のそれぞれの値、$u$は各変数の平均、$σ$は各変数の標準偏差です。ものすごくざっくりした言い方ですと、各値から平均を引いて、各変数の標準偏差、つまり散らばり具合で割っているので、色んな範囲に点在しているデータが、ぎゅっと寄せ集められるイメージです。

・・もっとよくわからないですね。

実際に数値を求めてみましょう。■平均$u$

$u$は平均なので、気温の5つのデータ全ての平均を計算すると、$(10+15+30+20+40)/5 = 23$になります。同様に、売上の平均を計算すると、$(400,000,000 + 390,000,000 + 410,000,000 + 405,000,000 + 395,000,000)/5 = 400,000,000$

となります。■標準偏差$σ$

計算過程は割愛しますが、

気温の標準偏差を計算すると約12になります。売上の標準偏差は7,905,694になります。

■標準化すると・・

下記の様な計算結果になり、標準化した気温列の数値と、標準化した売上列の数値を機械学習では使っていくということです。

気温 売上(円) 標準化した気温 標準化した売上 1 10 400,000,000 $(10-23)/12$ $(400,000,000-400,000,000)/7905694$ 2 15 390,000,000 $(15-23)/12$ $(390,000,000-400,000,000)/7905694$ 3 30 410,000,000 $(30-23)/12$ $(410,000,000-400,000,000)/7905694$ 4 20 405,000,000 $(20-23)/12$ $(405,000,000-400,000,000)/7905694$ 5 40 395,000,000 $(40-23)/12$ $(395,000,000-400,000,000)/7905694$ (2)なぜ平均0、標準偏差1になるの?

標準化の数式は$z = \frac{x -u}{σ}$と記載しましたが、この計算をすると平均0、標準偏差1になる証明をしていきましょう。

ここでは、$y = ax +b$の式で考えていきます。

<標準化していない、元の式の平均と標準偏差>

まず、シンプルに標準化前の平均と標準偏差を求めましょう。

求めてみるとわかりますが、平均も標準偏差も0や1ではありません。

■平均

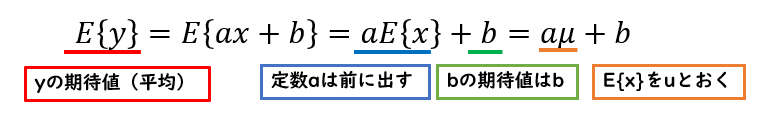

下記のように、$y$の平均は$aµ+b$と表せます。

※$E$は期待値を表していますが、期待値があまりわからない方はざっくり「平均」と捉えていただいても大丈夫です(厳密には異なります)。

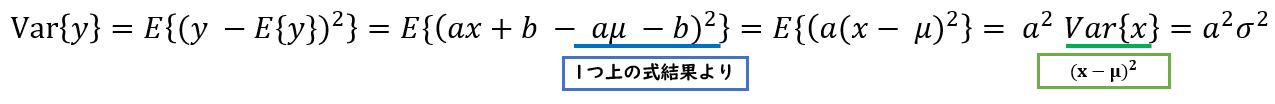

■標準偏差

まず分散を求めていて、結果は$a^2σ^2$です。(標準偏差は$aσ$)

<標準化した式の平均と標準偏差>

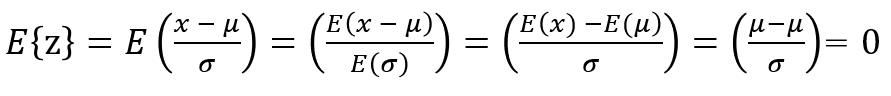

では次に、標準化した後の平均と標準偏差を求めていきましょう。

式変形の考え方は、基本的に標準化前の式変形と同じです。下記のように式変形をすると、標準化した後は平均0、標準偏差1になっていることがわかります!

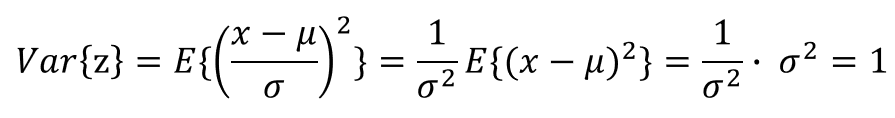

■標準偏差

こちらも先ほど同様、まずは分散を求めています。分散が1になるので、結局標準偏差も1になります。

以上で、標準化した後の各変数の平均は0、標準偏差が1になっていることが数式から証明することができました!

5.結び

以上、いかがでしたでしょうか。

私の思いとして、「最初からものすごい複雑なコードなんて見せられても自分で解釈できないから、精度は一旦どうでもいいのでまずはscikit-learn等で基本的な一連の流れを実装してみる」ことは非常に重要だと思っています。ただ、慣れてきたらそれらを裏ではどのように動かしているのか、数学的な背景から理解していくことも非常に重要だと感じています。

とっつきづらい内容も多いと思いますが、少しでも理解の深化の助けとなりましたら幸いです。

- 投稿日:2020-05-27T13:16:17+09:00

Zoom飲みでできる!!ジャストワン風協力型お題推測ゲームをFlask+Herokuで作ってみた

はじめに

私は、ボードゲームが好きだ。

ビールを飲みながらボードゲームをしている瞬間が至福だ。しかし、コロナウイルスの影響によって直接会ってボードゲームをすることが難しくなっている。

Zoomでもボードゲームを出来無いかと試したが、市販のボードゲームは直接集まってプレイすることが前提で作られているため、どうしても違和感があった。そこで、Zoomとの親和性の高い、Webブラウザでできるゲームがあれば違和感は消え、面白いのでは無いかと考えた。

お題を推測して当てるシンプルなゲームを作成した。

名前は、「ポレゲス」だ。ゲーム自体は、ジャストワンに似たゲームである。

今回は、そのゲームの概要や実装方法などをまとめていこうと思う。参考:【ゲーム紹介】ジャスト・ワン (Just One)|同じヒント禁止!お題の正解数を競う協力ワードゲーム!! | ニコボド|ボードゲームレビュー&情報系ブログ

作ったもの

お題をヒントから当て、みんなで高得点を目指す協力型のゲーム「ポレゲス」を作った。

回答者は、プレイヤーの提示するヒントとシステムが提供するスペシャルヒントからお題を当てる。

例えば、プレイヤーの提示するヒントが「ウィンブルドン」、「ボール」、「王子様」、「錦織圭」のときに、それらのヒントの共通項は「テニス」なので回答者はお題が「テニス」と推測することができる。このように、回答者がお題を推測できるようなヒントをプレイヤーが考えてあげることがこのゲームの肝である。

スペシャルヒントを使うともう一個ヒントを見ることができる。スペシャルヒントを使わずに正解すると2点、スペシャルヒントを使って正解すると1点、不正解だと-1点になる。

合計8回繰り返し、チームの合計得点を最大化することを目指します。ただし、以下の2点の制約がある。

①ヒントはお題の「表記違い」「外国語/方言」「同系」「造語」「同音異義語」はNG

例)お題がテニスの時は、「てにす」、「庭球」、「tennis」はNG②プレイヤー間でヒントが重複したときはヒントが無効

ブラウザで遊べるシンプルなWebアプリケーションとなっている。

以下のURLから無料で遊ぶことができる。↓

「Zoomで出来るリモートボードゲーム!協力型お題推測ゲーム ポレゲス」

遊び方

問題数:1回のゲームでお題は8問。

ゲーム人数:3~8人

準備するもの(ホスト):パソコン、紙、ペン

準備するもの(ユーザー):紙、ペン

プレイ時間:20~40分遊び方動画

実装内容(技術)

システムアーキテクチャとしては、flask+heroku+sqlie3を使って実装した。

flaskを用いたWebアプリケーション作成は初めてだったので、以下のチュートリアルをベースに作成していった。

参考:Flask-tutorialまた、UIとUXを大幅に更新した第二弾からは弟が積極的にコミットしてくれたので、認識の齟齬をなくすためにAdobe XDで、ワイヤーフレームを作成した。レスポンシブ化も気合でやってくれた。

兼ねてからの憧れの独自ドメインもお名前.comを利用して700円ほど課金して取得した。

また、herokuの方にも課金する必要があったので700円ほど課金した。課金するとSSLの運用を自動化してくれるACMも使うことができた。

参考:お名前.comお題

350個気合で考えた。一番しんどかった。

レベル分けも直感で振り分けた。

今後、プレイヤーが増えてきたら正誤の数によって精緻化していきたい。スペシャルヒント

word2vec

Wikipediaをコーパスとしてmeacb+word2vecを使えば、結構近いヒントが得られるのでは無いかと思い、学習させて試してみた。

スペシャルヒントの意味の近さの%はこれが元になっている。結果としては10個中1個程度くらいしかきちんとしたヒントとして使えなかった。

ただ、たまにとてもハッとするようなヒントも予測してくれた。(笑)

例)お題「帰宅難民」→ヒント「第二の災害」ランサーズ

word2vecがそこまで使えないことが分かったので、人的リソースに頼ることにした。

ランサーズと言われるクラウドソージングサイトで、350語のスペシャルヒントを発注した。プロジェクト形式にしたところ30件ほど応募が来たので1500円程度で2名にお願いすることができた。

1日で両名とも納品され、質もバッチリだったので非常に満足している。ただ、選定するのが少し面倒だった。

参考:ランサーズユーザー数

GoogleAnalyticsを導入しているが、ユーザー数は日次で5~70人の訪問数がある。

Google Search Consoleを見たところ、「リモートボードゲーム」で検索してたどり着いているユーザーが多いようだ。感想

友人や家族と「ポレゲス」をプレイしてみたら、十分面白くて満足だった。

ただ、ビールを飲むと全然ヒントが考えられない。。今後の展望

ブログやゲーミングプラットフォームに載せることで日次で100人は継続して、訪問してもらえるようにしたい。

また、Youtuberにも使って行ってもらい、プレイ動画などを上げていってもらいたい。

ひとりで遊べるモードもモチベーションが維持できれば開発しようと思っている。余談

Google Adsenseは落ちました。

いずれ、また申請してみます。

- 投稿日:2020-05-27T12:52:08+09:00

python ファイル操作関係まとめ

#Working With Files in Python #https://realpython.com/working-with-files-in-python/ #python3 import os from pathlib import Path import shutil #filepathからファイル名取得 basename = os.path.basename(filepath) basename_without_ext = os.path.splitext(os.path.basename(filepath))[0] #ファイルの存在確認 cwd = os.getcwd() cwd_f = cwd + "/"+filename if os.path.isfile(cwd_f) == True #ファイル読み取り #https://dbader.org/blog/python-file-io with open('data.txt', 'r') as f: data = f.read() print('context: {}'.format(data)) #ファイル読み取り&編集 with open('data.txt', 'w') as f: data = 'some data to be written to the file' f.write(data) #フォルダー&ファイルリストの取得 #フォルダー構造 # my_directory # ├── file1.py # ├── file2.csv # ├── file3.txt # ├── sub_dir # │ ├── bar.py # │ └── foo.py # ├── sub_dir_b # │ └── file4.txt # └── sub_dir_c # ├── config.py # └── file5.txt #方法1 entries = os.listdir('my_directory')#entriesはリスト for entry in entries: print(entry) #→['file1.py', 'file2.csv', 'file3.txt', 'sub_dir', 'sub_dir_b', 'sub_dir_c'] #方法2 python 3.5以後 with os.scandir('my_directory') as entries:#entriesはイテレータ for entry in entries: print(entry.name) #方法3 python 3.4以後 entries = Path('my_directory') for entry in entries.iterdir(): print(entry.name) #サブフォルダを含むリスト取得 for dirpath, dirname, files in os.walk('.'): print(f'Found directory: {dirpath}') for file_name in files: print(file_name) #ファイル判断 #方法1 for entry in os.listdir(basepath): if os.path.isfile(os.path.join(base_path, entry)): print(entry) #方法2 python 3.5以後 with os.scandir(basepath) as entries: for entry in entries: if entry.is_file(): print(entry.name) #方法3 python 3.4以後 basepath = Path('my_directory') for entry in basepath.iterdir(): if entry.is_file(): print(entry.name) # or basepath = Path('my_directory') files_in_basepath = (entry for entry in basepath.iterdir() if entry.is_file()) for item in files_in_basepath: print(item.name) #サブフォルダ取得 #方法1 for entry in os.listdir(basepath): if os.path.isdir(os.path.join(basepath, entry)): print(entry) #方法2 with os.scandir(basepath) as entries: for entry in entries: if entry.is_dir(): print(entry.name) #方法3 for entry in basepath.iterdir(): if entry.is_dir(): print(entry.name) #ファイルの編集時刻取得 #方法1 with os.scandir('my_directory') as entries: for entry in entries: info = entry.stat() print(info.st_mtime) #方法2 for entry in basepath.iterdir(): info = entry.stat() print(info.st_mtime) #※ 時刻変換関係 timestamp = int(info.st_mtime)#ms秒を削除 dt = datetime.datetime.utcfromtimestamp(info.st_mtime) #st_mtime→datetimeに dt = dt.strftime('%Y-%m-%d %H:%M:%S') #https://strftime.org/ #https://docs.python.org/3/library/datetime.html#strftime-and-strptime-behavior #フォルダ作成 #方法1 try: os.mkdir('directory') except FileExistsError as e: print(e) #方法2 p = Path('directory') try: p.mkdir() except FileExistsError as e: print(e) #※エラー無視時, p.mkdir(exist_ok=True) #※サブフォルダー作成 os.makedirs('floder/subf/sub') #一時ファイルの作成 from tempfile import TemporaryFile # 一時ファイル作成&データ入力 fp = TemporaryFile('w+t') fp.write('Hello World!') # データ読み込み fp.seek(0) data = fp.read() print(data) # ファイルを閉じる(自動削除) fp.close() #with バージョン with TemporaryFile('w+t') as fp: fp.write('i am good man!') fp.seek(0) fp.read() #一時フォルダの作成 import tempfile with tempfile.TemporaryDirectory() as tmpdir: print('Created temporary directory ', tmpdir) print(os.path.exists(tmpdir)) #ファイル削除 os.remove(file) #or os.unlink(file) #フォルダの削除 os.rmdir(dir) #or dir = Path('my_documents/bad_dir') dir.rmdir() #フォルダーツリーの削除 shutil.rmtree(dir_tree) #ファイルコピー shutil.copy(src, dst) #or shutil.copy2(src, dst)#ファイルのプロパティもコピー #フォルダーツリーのコピー dst = shutil.copytree('data', 'databackup') #ファイルおよびフォルダーの移動 dst = shutil.move('dir/', 'backup/') #ファイルおよびフォルダーのリネーム os.rename('first.zip', 'first_01.zip') #.txt ファイル探し #Strings and Character Data in Python #https://realpython.com/python-strings/ #方法1 for f_name in os.listdir('directory'): if f_name.endswith('.txt'): print(f_name) #方法2 import fnmatch for f_name in os.listdir('directory'): if fnmatch.fnmatch(f_name, 'data_*_2020*.txt'): print(f_name) #方法3 import glob for name in glob.glob('*/*/*[0-9]*.txt'):#サブフォルダ、0~9の文字を含むの.txtファイルを探し print(name) #zipファイルの読み込み import zipfile with zipfile.ZipFile('data.zip', 'r') as zipobj: for names in zipobj.namelist(): if os.path.isfile(names) info = zipobj.getinfo(names) print(info.file_size,bar_info.date_time,bar_info.filename) #zipファイルから指定ファイルの解凍 data_zip = zipfile.ZipFile('data.zip', 'r') #data.zipの中のfile1.pyを作業ディレクトリへ解凍 data_zip.extract('file1.py') #全てを指定フォルダーへ解凍 data_zip.extractall(path='extract_dir/') #パスワードある場合 data_zip.extractall(path='extract_dir', pwd='password') data_zip.close() #zipファイルの作成&追加 #作成 file_list = ['file1.py', 'sub_dir/', 'sub_dir/bar.py', 'sub_dir/foo.py'] with zipfile.ZipFile('new.zip', 'w') as new_zip: for name in file_list: new_zip.write(name) #追加 with zipfile.ZipFile('new.zip', 'a') as new_zip: new_zip.write('data.txt') new_zip.write('latin.txt') #tarファイルの読み込み import tarfile with tarfile.open('example.tar', 'r') as tar_file: #mode :['r','r:gz','r:bz2','w','w:gz','w:xz','a'] for entry in tar_file.getmembers(): print(entry.name) print(' Modified:', time.ctime(entry.mtime)) print(' Size :', entry.size, 'bytes') #or f = tar_file.extractfile('app.py') f.read() #tarファイルから指定ファイルの解凍 tar = tarfile.open('example.tar', mode='r') #カレントディレクトリに解凍 tar.extract('README.md') #全てを指定フォルダーへ解凍 tar.extractall(path="extracted/") #tarファイルの作成&追加 #作成 import tarfile file_list = ['app.py', 'config.py', 'CONTRIBUTORS.md', 'tests.py'] with tarfile.open('packages.tar', mode='w') as tar: for file in file_list: tar.add(file) #追加 with tarfile.open('package.tar', mode='a') as tar: tar.add('foo.bar') #確認 with tarfile.open('package.tar', mode='r') as tar: for member in tar.getmembers(): print(member.name) #shutil.make_archive()でフォルダー圧縮 import shutil #dataフォルダーしたのファイルをbackup.tarに圧縮 shutil.make_archive('data/backup', 'tar', 'data/') #解凍 shutil.unpack_archive('backup.tar', 'extract_dir/') #複数ファイルの読み込み #https://docs.python.org/3/library/fileinput.html import fileinput,sys for line in fileinput.input(): if fileinput.isfirstline(): print(f'\n--- Reading {fileinput.filename()} ---') print(' -> ' + line, end='')

- 投稿日:2020-05-27T12:27:13+09:00

Pythonの基礎

まえおき

- この記事は執筆中のやさしくはじめるPythonプログラミングの本の特定の章の部分抜粋です。

- 入門本なので初心者の方向け。

- Pythonの基本的なところの章が対象となります。

- Qiita記事にマッチしていない箇所(「章」や「ページ」といった単語が使っていたり、改行数が余分だったり、リンクが対応していない等)があるという点はご留意ください。

面倒なのでQiita用に調整するのやりたくない。気になる方は↑のリンクの電子書籍版をご利用ください。- コメントなどでフィードバックいただいた場合、書籍側にも活用・反映させていただく場合があります。

Pythonの基礎

この章では、Pythonの基本的なところを学んでいきます。地味な内容もまだ多いですが、大切な内容であり且つ基礎がしっかりしていると学習がスムーズになります。スキップせずに、且つ実際に皆さん自身で手を動かしてコードを実行してみて進めてみてください。

足し算、引き算・掛け算...基本的な計算

前の章でも少し出てきましたが、基本的な足し算などの計算方法を見ていきます。

数字や記号は全部半角なので気を付けて

計算に進む前に全角半角について触れておきます。

各コードは全角だと動いてくれないので、半角の数字や記号などを使用してください。序盤のうちは全角で打ってしまったりも結構してしまうと思いますが、そうすると以下のようにエラーになってしまいます。

3 * 3File "<ipython-input-26-7de8af1d1fd9>", line 1 3 * 3 ^ SyntaxError: invalid character in identifierinvalidは「無効な」といった意味で、characterは「文字」、indentifierは「識別子」といったような意味ですが、意味が分かりづらいので特定の(プログラムの)文字列の部分で、といった意味で現状では捉えてみてください。

プログラムの文字列の中に無効な文字が含まれていますよ、というエラーメッセージです。

また、エラーの内容にある

^の記号は、上の部分が無効な文字の部分ですよ、ということを指しています。上記の例だと全角のアスタリスクが指し示してあり、そこが修正が必要(半角にする必要がある)なことが分かります。また、Jupyter上では半角の記号にちゃんとなっていれば、文字が紫色になったりします。全角の場合は黒のままです。

大きさだけではなく色でも識別できるようになっているので、うっかり全角で入力してしまった時など参考にしてみてください。

足し算

まずは足し算の方法です。加算などとも呼ばれます。英語だとAdditionとなり、プログラムでaddといった記述が出てきたら足し算のことを指していることが多いです。

数値 + 数値の形式で、数値の間に半角のプラスの記号を挟むことでPythonで計算することができます。3 + 4コード実行結果の出力内容:

7

他の計算も同様ですが、複数の数値で計算することもできます。

3 + 4 + 5コード実行結果の出力内容:

12

引き算

続いて引き算の方法です。減算などとも呼ばれ、英語だとSubtractionとなり、プログラム上ではsubなどという名前で使われたりします。

数値 - 数値の形式で、数値の間に半角のマイナスの記号(ハイフン)を挟むことでPythonで計算することができます。5 - 2コード実行結果の出力内容:

3

掛け算

掛け算は乗算などとも呼ばれます。英語だとMultiplicationとなります。

プログラム上ではmulなどの名前で使われたりします(例 : 高校や大学などで学ぶ行列関係でmatmulといった具合に)。

数値 * 数値の形式で、数値の間に半角のアスタリスクの記号は挟むことでPythonで計算することができます。3 * 4コード実行結果の出力内容:

12

割り算

割り算は除算なととも呼ばれます。英語だとdivisionとなります。

少し前のセクションで触れた、0除算のエラー(ZeroDivisionError)でもこの英単語は出てきましたね。

数値 / 数値の形式で、数値の間に半角のスラッシュの記号を挟むことでPythonで計算することができます。5 / 2コード実行結果の出力内容:

2.5

余り

次はとある数で割った際の割り切れない分の値(余り)の計算に関してです。剰余などとも呼ばれます。英語だとremainderとかmoduloなどになります。

数値 % 数値の形式で、数値の間に半角のパーセントの記号を挟むことでPythonで計算することができます。6 % 4コード実行結果の出力内容:

2

累乗計算

続いて「2の3乗」みたいな、累乗計算の方法です。べき乗などとも呼ばれます。英語だとpowerといった英単語が使われます。「2の累乗」で「a power of two」といった感じの英語になります。

Pythonでは

数値 ** 数値の形式で、数値の間に半角のアスタリスクを2つ連続して記述することで計算できます。1つだけだと通常の掛け算になってしまうので注意してください。2 ** 3コード実行結果の出力内容:

2

演算子と代数演算子の話

重要度 : ★☆☆☆☆(最初は知らなくてもいいかも)

プログラミングで色々な計算を行う際に使われる記号などは演算子と呼ばれます。英語ではoperatorとなります。

今までに出てきた足し算のプラスや掛け算のアスタリスクなどの記号は、演算子の中でも代数演算子と呼ばれます。

今後、プログラミング関係の記事や本でよく演算子という単語が出てくると思いますが、とりあえずは「計算などをするときに必要になるプラスとかの記号のことなんだな」程度に頭の片隅に入れておいてください。

あなたの年齢は?変数入門

プログラムでは、値に名前を付けると便利なことが多々あります。例えば、「私の年齢」という名前の値を考えてみましょう。

「私の年齢」という名前の値が用意されていると、その値に応じて、ケーキのロウソクの本数を決定する、みたいなプログラムを書くことができます。

また、この値は固定ではなく誕生日を迎えるごとに値が1増えていきます。

このような特定の条件で値が変わり、且つ名前が付けられたものを「変数」と言います。英語だとvariableといいます。短縮されてvarなどと表記されることも多くあります。

年齢が毎年変わるのと同様に、「変わる数」という意味合いを持ちます。ただし、数と付いていますが別に内容は数値に限ったことではありません。「あなたの名前」といった文字列が設定されたりもします。どちらかというと「変わりうるデータ」という方が意味合いが近いかもしれません。

「私の年齢」は「25」です、といったように定義することを「変数宣言」とか「変数定義」と言います。英語では「define a variable」といった感じに、「define」という単語が使われます。もしくは、「割り当てる」という意味でのassignを使って、「assign a variable」や「variable assignment」といった風に使われます。

変数の名前はそのまま変数名(variable name)と呼ばれ、この例では「私の年齢」部分が変数名となります。

Pythonで変数を定義するには、

変数名 = 変数の値という形で変数名と変数の値の間にイコールを記述することで定義することができます。プログラムの変数名は基本的に、計算の時の記号と同様に全て半角の英数字や記号などで表現します(一部例外のケースはあります)。

Pythonだと全角の文字を使っても動いたりしますが、一般的なプログラミングの慣習では半角が基本となりますので、全角の英数字を使わないように気を付けてください。

変数名は、複数の英単語から構成される場合には、間をスペースではなく半角のアンダースコア(

_)などの記号で単語を繋いだりして表現します。もしくはアンダースコア自体を省略するケースもPythonだと良くあります。例えば、「私の年齢」という変数名では

my_ageといったように変数名を付けます。先ほどの例で変数宣言をしてみると、以下のような形になります。

my_age = 25このように変数に値を設定(代入)するような、イコールの記号の演算子は「代入演算子」と呼ばれます(英語だとassignment operator)。

変数の内容を確認する

変数の中身(値)を確認するには、

print(変数)というフォーマットでプログラムを書きます。print(my_age)といった具合です。この

my_age = 25 print(my_age)コード実行結果の出力内容:

25

また、Jupyter上であればprintを省略しても、その変数単体をセルに入力してある場合(厳密には違いますが)にセルを実行すれば変数の内容を確認することができます。

JupyterのOut[]部分に変数の内容が表示されます。

変数の内容を変更する

変数の内容を変更するには、もう一度同じ変数名でイコールの記号を使うことで設定ができます。

たとえば、先ほどの変数の

my_ageの値を25から26に変更するには以下のように記述します。25の値を設定するときと一緒ですね。my_age = 26足し算と変数の更新を同時に行う : 加算代入演算子

また、変数の値が数値の場合、プラスやマイナスなどの記号とイコールを一緒に記述することで、「現在の値に対して」計算をすることができます。

例えば、

my_ageという変数の値を1プラスする際には、my_age += 1といったような書き方になります。変数への値の設定と足し算を同時にやっているので、「加算代入演算子」と呼ばれます(英語だとaddition assignment operator)。

引き算なども同様に、「減算代入演算子(subtraction assignment operator)」

「乗算代入演算子(multiplication assignment operator)」、「除算代入演算子(division assignment operator)」と名前が付いています。何だか小難しい漢字が並んでいますが、ゆっくりと時間をかけて用語は覚えていけばいいので、今は「足し算などと変数への値の設定を同時にやれる」ということだけを覚えておけば大丈夫です。

一応本書では各用語にもある程度触れていきますが、プログラムを楽しむ上では重要ではないのと、長いことプログラミングをしていれば自然と少しずつ覚えていけるので気楽に構えていただいて問題ありません。

加算代入演算子を使うには、変数に事前に数値を入れておく必要があります。例えば、

my_age = 25といったコードが必要になります。数値が入った変数に対して、以下のように加算代入演算子などを使えます。

my_age = 25 my_age += 2 print(my_age)コード実行結果の出力内容:

27

最初に変数に設定した25の値に2プラスされて、結果のprint部分で表示される変数の内容が27となっていることが分かります。

なお、加算代入演算子を使う代わりに、以下のようにただの代入演算子(イコールだけの記号)を使って

my_age = my_age + 2とプログラムを書いても同じ27という結果になります。my_age = 25 my_age += 2 print(my_age)コード実行結果の出力内容:

27

どちらの書き方も「変数の現在の値に対して」値を足している形になるため、プログラムの結果は変わりません。

ただし、加算代入演算子(

+=)を使った書き方の方が大体のケースでシンプルになります。

加算代入演算子が使えるケースではそちらの利用がおすすめです。引き算と変数の更新を同時に行う : 減算代入演算子

+=の記号を使う加算代入演算子と同様に、-=の記号を使う形で「現在の変数の値に対して引き算を行う」計算を行うことができます。こちらの記号は減算代入演算子(subtraction assignment operator)と呼ばれます。挙動や使い方は足し算の部分が引き算になるだけで、他は加算代入演算子のときと同じです。

my_age = 25 my_age -= 2 print(my_age)コード実行結果の出力内容:

23

掛け算と変数の更新を同時に行う : 乗算代入演算子

*=の記号を使うと、前のセクションで触れた加算や減算と同様に「現在の変数の値に対して掛け算を行う」計算を行うことができます。こちらの記号は乗算代入演算子(multiplication assignment operator)と呼ばれます。挙動は足し算や引き算のものと同様で、内容が掛け算になるだけです。

my_money = 1000 my_money *= 3 print(my_money)コード実行結果の出力内容:

3000

割り算と変数の更新を同時に行う : 除算代入演算子

足し算、引き算、掛け算と来たので、勿論割り算もあります。

/=の記号を使うと、「現在の変数の値に対して割り算を行う」計算を行うことができます。こちらの記号は除算代入演算子(division assignment operator)と呼ばれます。my_money = 1000 my_money /= 4 print(my_money)コード実行結果の出力内容:

250.0

型ってなに?

今後、色々本を進めていくにつれて、「型」という概念が重要になってきます。

英語だとtypeとなります。初めて見ると型とはなんだろう?という感じですが、重要な内容なので、このセクション以降では基本を丁寧に説明していきます。

説明のために、アスタリスクの記号を使った以下の数値の掛け算のコードと結果を見てみてください。

2 * 5コード実行結果の出力内容:

10

結果が10となりました。

続いて、数値ではなく文字に対して掛け算と同じアスタリスクでのコードを実行してみるとどうなるでしょうか?

Pythonで文字は

''などのクォーテーションと呼ばれる記号で囲むと表現できます。'猫' * 5コード実行結果の出力内容:

猫猫猫猫猫

今度は文字が5個になりました。

2や'猫'といった値に応じて、挙動が変わっていますね。このように、プログラムでは値に応じて振る舞いが変わります(数値の場合はこうなる、文字の場合はこうなる、といったように)。

また、値によってできることとできないことが異なります。

この数値や文字などの種類が、それぞれ「型」になります。Pythonでは、数値や文字などの他にも様々な型が存在します。

「振る舞いが違う色々な値の種類」と考えると少し分かりやすいかもしれません。

色々な型がありますが、次のセクション以降で少しずつ触れていきます。一度にたくさん覚えようとすると大変なので気楽に進めていただいて、忘れたときにはそこだけ復習するといった具合に進めてみてください。

焦らなくても、プログラムを書き続けてさえいれば自然と身についてきたり、覚えているものの数が増えていきます。

| 2, 5, 20...整数(int)の入門

整数の型はintとなります。英語だと整数がintegerなので、その略称としてPythonでは型の名前がintとなっています。

今まで出てきたPythonの基本計算でも既に色々使ってきましたね。

変数へ整数を設定するには、今まで触れてきた通り

=の記号を使いつつ、右辺に整数の値を配置すれば設定できます。my_age = 10 print(my_age)コード実行結果の出力内容:

10

また、型の確認は

type()と書いて()の括弧の中に値を直接入れたり、変数を入れたりすることで確認ができます。以下のようにコードを書く と、値はintですよ、ということを確認できます(もしくは、Jupyter上であればセルの末端であればprint部分を省略しても型の内容を確認できます)。

my_age = 10 print(type(my_age))コード実行結果の出力内容:

<class 'int'>

class 'int'という形で表示されていますが、class部分については後々別のセクションで触れていきます。この

type()での型の調べ方は、他の値でも使えます。| 1.5, 0.05, 30.3...浮動小数点数(float)の入門

1.5や0.05といった、少数の値を含んだ数値はfloatという型で扱います。

特に、コンピューター・プログラミング関係では浮動小数点数という形で少数を扱います。英語だとfloating point numberとなり、そこにfloatという型の名前が由来しています。

浮動小数点数と対になるもので固定小数点数というものもあります。

浮動小数点数に「動」という漢字がありますが、これは小数点の位置が動いても扱える、という意味合いを持ちます。0.01でも538.1500023といった値でも扱えます。

一方で、固定小数点数は決められた小数点の位置しか扱えません。1030.3123や0391.8812といった値になります。

浮動小数点数の方が、少数点部分が柔軟に扱える(扱える数値の範囲が広い)代わりに、固定小数点数の方が計算が速いという特徴がありますが、基本的に普通に触っている分にはほぼ浮動小数点で困ることはありません。

一応、Pythonでは固定小数点数も利用ができるのですが、基本的には一部の特殊なケース以外、ほぼほぼ浮動小数点数しか利用しません。そのため、小数を扱うときには浮動小数点数のfloatを使うと考えていていただいても問題ありません。

この辺りは小難しい話ですし、固定小数点数が必要になるケースは少ないと思うので、深くはこの本では触れません。

浮動小数点数を扱うには、半角の数字と半角のドット

.の記号を使って表現します。pi = 3.1415 print(pi)コード実行結果の出力内容:

3.1415

普通に変数に設定する以外にも、最初は整数の型(int)だったものが、計算の途中で浮動小数点数(float)になっている、などのケースもあります。例えば、割り算を

/=の記号を使ってしてみると、最初はintの型だったものがfloatになっていることが分かります。money = 1000 print(type(money))コード実行結果の出力内容:

<class 'int'>

上記のように、変数宣言の時点では整数(int)になっています。

money = 1000 money /= 6 print(type(money))コード実行結果の出力内容:

<class 'float'>

割り算をしたら型が浮動小数点数(float)になりました。これは、割り算によって変数(money)の値が

166.66666666666666といったように、小数が必要な値に変化したことによってPython側が自動で変換してくれています(割り切れる計算の場合でも、割り算をすると基本的に結果は浮動小数点数になります)。'りんご', '猫', '晴れ'...文字列(str)の入門

日本語や英語などの文字はstrという型で扱います。

猫とかaといった単一の文字は英語でcharacterとなります。プログラミングではよくcharなどと短くした形で使われます。

ペルシャ猫やappleといった、複数の文字からなるものを、文字列と呼びます。文字列は英語でstringで、Pythonの文字を扱う型のstrはこの英語に由来します。1文字のときも複数文字の場合も、両方とも同じstrの型で扱えます。

文字列を扱うには、

'の記号(シングルクォーテーションと呼ばれます。英語だとsingle quotationとなります)で文字列を囲むか、"の記号(ダブルクォーテーションと呼ばれます。英語ではdouble quotation)で文字列を囲む必要があります。例えば、

'ペルシャ猫'といった形や、"ペルシャ猫"といったように'や"の記号を使って表現します。シングルクォーテーションを使ったサンプル :

cat_name = 'ペルシャ猫' print(cat_name)コード実行結果の出力内容:

ペルシャ猫

ダブルクォーテーションを使ったサンプル :

cat_name = "ペルシャ猫" print(cat_name)コード実行結果の出力内容:

ペルシャ猫

シングルクォーテーションを使ってもダブルクォーテーションを使っても基本的な文字列の挙動は変わりません。

ただし、例えば文字列の中にシングルクォーテーションやダブルクォーテーションが含まれる場合には、含まれていない方のクォーテーションを使うとシンプルになります。

文字列内にシングルクォーテーションが含まれているので、ダブルクォーテーションを使っているサンプル :

string = "That's it." print(string)コード実行結果の出力内容:

That's it.

シングルクォーテーションを含んだ文字列に対してシングルクォーテーションを使うことも一応はできます。ただし、「エスケープ」という対応が必要になります。

エスケープは、

\記号(環境によって、半角のバックスラッシュもしくは半角の円記号で表示されます)を使います。文字列内でこのエスケープ用の

\記号の後に設定された文字は、「特殊な挙動をしないただの文字」になります。シングルクォーテーションやダブルクォーテーションはPythonでは文字を囲むための特殊な挙動をします。それがエスケープ用の記号を直前に置くことで、プログラム的に意味を持たないただの文字となります。

前述のシングルクォーテーションを含む文字列のサンプルで、エスケープをしながらシングルクォーテーションで囲むには

That\'s it.といったように、シングルクォーテーションの直前に\記号を配置してください。string = 'That\'s it.' print(string)コード実行結果の出力内容:

That's it.

また、仕事などで複数人でPythonのコードを書くようなケースでは、人によってシングルクォーテーションを主に使うのかダブルクォーテーションを主に使うのかがバラバラで、そのままだと各クォーテーションがごちゃまぜになってしまいます。

そういったことを避けるために、コードを扱う各プロジェクトで「基本的にはシングルクォーテーションをメインに使う」とか、逆に「基本的にはダブルクォーテーションをメインに使う」といったルールを決めることが多いです。

※前述のように、メインで使うのはシングルクォーテーションだけれども、文字列内にシングルクォーテーションが含まれているから例外的に一部たけダブルクォーテーションを使う、といったことは問題ありません。

こういったルールの集まりを、「コーディングルール」とか「コーディング規約」等と呼びます。

参考までに、PEP8という、Pythonのプログラム自体のコーディング規約にも、どちらをメインで使うのかを各々で決めてください、という記述があります(20年前くらいのドキュメントになります)。

Python では、単一引用符 ' で囲まれた文字列と、二重引用符 " で囲まれた文字列は同じです。この PEP では、どちらを推奨するかの立場は示しません。どちらを使うかのルールを決めて、守るようにして下さい。

必須ではありませんが、皆さんの好みや仕事で複数人での作業が必要になった場合は同僚の方と相談したりして、どちらをメインに使っていくのかを必要に応じて決めてください。

本書ではシングルクォーテーションをメインに使っていきます。

文字列の連結

数値の時は

+の記号を使うと足し算となりました。文字列で+の記号を使うと、文字列同士の連結になります。以下のサンプルでは、

apple_nameという文字列の変数とorange_nameという文字列の変数を+の記号を使って連結して、最終的に1つの文字列の変数のconcatenated_strにしています。apple_name = 'りんご' orange_name = 'オレンジ' concatenated_str = apple_name + orange_name print(concatenated_str)コード実行結果の出力内容:

りんごオレンジ

複数のクォーテーションによる文字列の連結

また、複数のクォーテーション区切りの文字列が連続していても1つの値(変数)になります。

fruit_name = 'りんご''オレンジ''メロン' print(fruit_name)コード実行結果の出力内容:

りんごオレンジメロン

もちろん、前述のサンプルのようにクォーテーションを複数使わなくても以下の1つの文字列にはなってくれます。

fruit_name = 'りんごオレンジメロン' print(fruit_name)コード実行結果の出力内容:

りんごオレンジメロン