- 投稿日:2019-12-18T22:52:17+09:00

GoのSpannerクライアントについて ReadOnlyTransaction編

QualiArts Advent Calendar 2019、20日目担当のs9iです。

弊社の新規タイトルでは、バックエンドのプログラミング言語にGo、データベースにCloud Spannerを採用しています。今回はGoでSpannerを使用する際に使う、公式クライアントライブラリの使い方について書いていきます。

Cloud Spannerとは

2017年にGoogleから公開されたフルマネージドのデータベースです。

詳細な説明はここでは割愛しますが、

- リージョンを跨いだ水平スケール

- RDBとしての特性(スキーマ、トランザクション、SQL ...)

- ノード数を増やすほどスループット向上

といった特徴があります。弊社でも、RDBの特性と自動で行われる水平スケールに特に魅力を感じ、採用に至りました。

Spannerのトランザクション

Spannerには2種類のトランザクションがあります。

- ReadOnlyTransaction

- ReadWriteTransaction

この2種類を処理に応じて使い分けることで、より効率の良いデータベース操作が可能となります。本記事では、主にReadOnlyTransactionの使用方法を記します。

トランザクションの詳細についてはこちらの記事が非常に参考になります。詳解 google-cloud-go/spanner — トランザクション編

Spannerクライアントの使用方法

本記事では、

- go 1.13

- cloud.google.com/go/spanner 1.1.0

を使用しています。

スキーマ定義

今回説明に使用するテーブルとして、以下のItemテーブルを定義します。

(本来、Spannerではプライマリキーに基づいてデータのシャーディングが行われるので、連続値等の偏りがある値をプライマリキーに指定するべきではありません。その他についても突っ込みどころは多々ありますが、説明用のテーブルということでご了承ください。)CREATE TABLE Item( ItemID INT64 NOT NULL, ItemType STRING(MAX) NOT NULL, Name STRING(MAX) NOT NULL, Effect INT64 NOT NULL, Description STRING(MAX), ) PRIMARY KEY(ItemID, ItemType); CREATE INDEX IdxItemName ON Item(Name);こちらのテーブルに以下のデータを入れておきます。

ItemID ItemType Name Effect Description 1 Type1 アイテム1 10 説明1-1 1 Type2 アイテム2 20 説明1-2 1 Type3 アイテム3 30 説明1-3 1 Type4 アイテム4 40 説明1-4 2 Type1 アイテム5 50 説明2-1 2 Type2 アイテム6 60 説明2-2 2 Type3 アイテム7 70 説明2-3 3 Type1 アイテム8 80 説明3-1 3 Type2 アイテム9 90 説明3-2 4 Type1 アイテム10 100 NULL Spannerクライアントの生成

cloud.google.com/go/spannerパッケージのNewClient()でクライアントを生成します。

セッションの設定や認証情報等を指定する場合は、NewClientWithConfig()を使用します。import "cloud.google.com/go/spanner" // projectID:GCPプロジェクトのID // instance:Spannerのインスタンス名 // db:Spannerのデータベース名 func NewClient(ctx context.Context, projectID, instance, db string) (*spanner.Client, error) { dbPath := fmt.Sprintf("projects/%s/instances/%s/databases/%s", projectID, instance, db) client, err := spanner.NewClient(ctx, dbPath) if err != nil { return nil, errors.New("Failed to Create Spanner Client.") } return client, nil }Read

SpannerクライアントのReadOnlyTransaction()を用いて読み取り専用トランザクションを開始します。直後にdeferでクローズ処理を登録しておきましょう。

取得したトランザクションのRead()で検索処理が実行できます。こちらも忘れずにdeferでイテレータのStop()を実行しましょう。func ReadOnlyTxRead(ctx context.Context, client *spanner.Client) error { rtx := client.ReadOnlyTransaction() defer rtx.Close() // コンテキスト, テーブル名, キー, カラムの順で指定 iter := rtx.Read(ctx, "Item", spanner.AllKeys(), []string{"ItemID", "ItemType", "Name"}) defer iter.Stop() for { row, err := iter.Next() if err == iterator.Done { break } if err != nil { return err } var itemID int64 var itemType, name string // Read()で指定したカラム順で取得できる if err := row.Columns(&itemID, &itemType, &name); err != nil { return err } fmt.Printf("%d %s %s\n", itemID, itemType, name) } return nil }# 出力結果 1 Type1 アイテム1 1 Type2 アイテム2 1 Type3 アイテム3 1 Type4 アイテム4 2 Type1 アイテム5 2 Type2 アイテム6 2 Type3 アイテム7 3 Type1 アイテム8 3 Type2 アイテム9 4 Type1 アイテム10今回の例ではrow.Columns()を用いて値をバインドしていますが、構造体に一括でバインドするrow.ToStruct()や、カラム名を指定してバインドするrow.ColumnByName()も使用できます。

Read(カラムがNullを含む場合)

指定したカラムがNullを含む場合は、NullXxx型で値を取得した後、フィールドのValidで値の有無を判定します。

func ReadOnlyTxRead(ctx context.Context, client *spanner.Client) error { rtx := client.ReadOnlyTransaction() defer rtx.Close() iter := rtx.Read(ctx, "Item", spanner.AllKeys(), []string{"ItemID", "ItemType", "Name", "Description"}) defer iter.Stop() for { row, err := iter.Next() if err == iterator.Done { break } if err != nil { return err } var itemID int64 var itemType, name string var uncheckedDescription spanner.NullString if err := row.Columns(&itemID, &itemType, &name, &uncheckedDescription); err != nil { return err } var description string if uncheckedDescription.Valid { description = uncheckedDescription.String() } fmt.Printf("%d %s %s %s\n", itemID, itemType, name, description) } return nil }# 出力結果 1 Type1 アイテム1 説明1-1 1 Type2 アイテム2 説明1-2 1 Type3 アイテム3 説明1-3 1 Type4 アイテム4 説明1-4 2 Type1 アイテム5 説明2-1 2 Type2 アイテム6 説明2-2 2 Type3 アイテム7 説明2-3 3 Type1 アイテム8 説明3-1 3 Type2 アイテム9 説明3-2 4 Type1 アイテム10Read(特定のキーを指定する場合)

上記の例で使用していたspanner.AllKeys()はすべてのキーを指定するものでした。特定のキーを指定したい場合は、spanner.Keyでキーの順序に合わせて値を指定してあげます。

func ReadOnlyTxRead(ctx context.Context, client *spanner.Client) error { rtx := client.ReadOnlyTransaction() defer rtx.Close() keySet := spanner.KeySets(spanner.Key{1, "Type4"}, spanner.Key{3, "Type2"}) iter := rtx.Read(ctx, "Item", keySet, []string{"ItemID", "ItemType", "Name"}) defer iter.Stop() for { row, err := iter.Next() if err == iterator.Done { break } if err != nil { return err } var itemID int64 var itemType, name string if err := row.Columns(&itemID, &itemType, &name); err != nil { return err } fmt.Printf("%d %s %s\n", itemID, itemType, name) } return nil }# 出力結果 1 Type4 アイテム4 3 Type2 アイテム9Read(キー範囲を指定する場合)

キーの範囲を指定する場合はspanner.KeyRangeを使用します。

Start, Endでキーの境界を指定し、Kindで境界値を含むかどうかを指定できます。func ReadOnlyTxRead(ctx context.Context, client *spanner.Client) error { rtx := client.ReadOnlyTransaction() defer rtx.Close() keyRange := spanner.KeyRange{ Start: spanner.Key{1, "Type4"}, End: spanner.Key{3, "Type2"}, Kind: spanner.OpenOpen, } iter := rtx.Read(ctx, "Item", keyRange, []string{"ItemID", "ItemType", "Name"}) defer iter.Stop() for { row, err := iter.Next() if err == iterator.Done { break } if err != nil { return err } var itemID int64 var itemType, name string if err := row.Columns(&itemID, &itemType, &name); err != nil { return err } fmt.Printf("%d %s %s\n", itemID, itemType, name) } return nil }# 出力結果 2 Type1 アイテム5 2 Type2 アイテム6 2 Type3 アイテム7 3 Type1 アイテム8ReadUsingIndex

セカンダリインデックスを指定して検索を行う場合は、ReadUsingIndex()を使用します。

Spannerのセカンダリインデックスは、1つのテーブルとして扱われ、そのインデックステーブルに含まれるのは以下のカラムだけです。

- プライマリキー

- インデックスとして指定したカラム

- Storing句で指定したカラム

そのため、ReadUsingIndexにおいては上記のカラム以外を取得することはできません。(後述のQuery()を使用することで上記以外のカラムも取得できますが、これは元テーブルとのJoinが実行されているのでパフォーマンス面の考慮が必要です。)

func ReadOnlyTxReadUsingIndex(ctx context.Context, client *spanner.Client) error { rtx := client.ReadOnlyTransaction() defer rtx.Close() // PKとインデックス以外のカラム(Effect, Description)は取得できない iter := rtx.ReadUsingIndex(ctx, "Item", "IdxItemName", spanner.AllKeys(), []string{"ItemID", "ItemType", "Name"}) defer iter.Stop() for { row, err := iter.Next() if err == iterator.Done { break } if err != nil { return err } var itemID int64 var itemType, name string if err := row.Columns(&itemID, &itemType, &name); err != nil { return err } fmt.Printf("%d %s %s\n", itemID, itemType, name) } return nil }# 出力結果 1 Type1 アイテム1 4 Type1 アイテム10 1 Type2 アイテム2 1 Type3 アイテム3 1 Type4 アイテム4 2 Type1 アイテム5 2 Type2 アイテム6 2 Type3 アイテム7 3 Type1 アイテム8 3 Type2 アイテム9ReadRow

1行だけを読み取る場合にはReadRow()が使用できます。

イテレータから読み取る処理が内部で行われています。func ReadOnlyTxReadRow(ctx context.Context, client *spanner.Client) error { rtx := client.ReadOnlyTransaction() defer rtx.Close() row, err := rtx.ReadRow(ctx, "Item", spanner.Key{"2", "Type1"}, []string{"ItemID", "ItemType", "Name"}) if err != nil { return err } var itemID int64 var itemType, name string if err := row.Columns(&itemID, &itemType, &name); err != nil { return err } fmt.Printf("%d %s %s\n", itemID, itemType, name) return nil }# 出力結果 2 Type1 アイテム5ReadWithOptions

ReadWithOptions()はspanner.ReadOptionsを引数に取り、使用するインデックスと取得件数を指定して検索処理を行います。

func ReadOnlyTxReadWithOptions(ctx context.Context, client *spanner.Client) error { rtx := client.ReadOnlyTransaction() defer rtx.Close() opts := &spanner.ReadOptions{ Index: "IdxItemName", Limit: 2, } iter := rtx.ReadWithOptions(ctx, "Item", spanner.AllKeys(), []string{"ItemID", "ItemType", "Name"}, opts) defer iter.Stop() for { row, err := iter.Next() if err == iterator.Done { break } if err != nil { return err } var itemID int64 var itemType, name string if err := row.Columns(&itemID, &itemType, &name); err != nil { return err } fmt.Printf("%d %s %s\n", itemID, itemType, name) } return nil }# 出力結果 1 Type1 アイテム1 4 Type1 アイテム10Query

Query()を用いると任意の検索クエリを組み立てることができます。

キーバリューの形式でParamsを指定することで、プレースホルダーも使用できます。func ReadOnlyTxQuery(ctx context.Context, client *spanner.Client) error { rtx := client.ReadOnlyTransaction() defer rtx.Close() sql := `SELECT ItemID, ItemType, Name FROM Item WHERE ItemID = @ItemID` params := map[string]interface{}{"ItemID": 2} iter := rtx.Query(ctx, spanner.Statement{SQL: sql, Params: params}) defer iter.Stop() for { row, err := iter.Next() if err == iterator.Done { break } if err != nil { return err } var itemID int64 var itemType, name string if err := row.Columns(&itemID, &itemType, &name); err != nil { return err } fmt.Printf("%d %s %s\n", itemID, itemType, name) } return nil }# 出力結果 2 Type1 アイテム5 2 Type2 アイテム6 2 Type3 アイテム7AnalyzeQuery

クエリの実行計画を取得したい場合は、AnalyzeQuery()を使用します。

func ReadOnlyTxAnalyzeQuery(ctx context.Context, client *spanner.Client) error { rtx := client.ReadOnlyTransaction() defer rtx.Close() sql := `SELECT ItemID, ItemType, Name FROM Item WHERE ItemID = @ItemID AND ItemType = @ItemType` params := map[string]interface{}{ "ItemID": 2, "ItemType": "Type3", } plan, err := rtx.AnalyzeQuery(ctx, spanner.Statement{SQL: sql, Params: params}) if err != nil { return err } for _, node := range plan.GetPlanNodes() { fmt.Printf("%v\n", node) } return nil }# 出力結果 kind:RELATIONAL display_name:"Distributed Union" child_links:<child_index:1 > child_links:<child_index:18 type:"Split Range" > metadata:<fields:<key:"subquery_cluster_node" value:<string_value:"1" > > > index:1 kind:RELATIONAL display_name:"Distributed Union" child_links:<child_index:2 > metadata:<fields:<key:"call_type" value:<string_value:"Local" > > fields:<key:"subquery_cluster_node" value:<string_value:"2" > > > index:2 kind:RELATIONAL display_name:"Serialize Result" child_links:<child_index:3 > child_links:<child_index:15 > child_links:<child_index:16 > child_links:<child_index:17 > index:3 kind:RELATIONAL display_name:"FilterScan" child_links:<child_index:4 > child_links:<child_index:14 type:"Seek Condition" > index:4 kind:RELATIONAL display_name:"Scan" child_links:<child_index:5 variable:"ItemID" > child_links:<child_index:6 variable:"ItemType" > child_links:<child_index:7 variable:"Name" > metadata:<fields:<key:"scan_target" value:<string_value:"Item" > > fields:<key:"scan_type" value:<string_value:"TableScan" > > > index:5 kind:SCALAR display_name:"Reference" short_representation:<description:"ItemID" > index:6 kind:SCALAR display_name:"Reference" short_representation:<description:"ItemType" > index:7 kind:SCALAR display_name:"Reference" short_representation:<description:"Name" > index:8 kind:SCALAR display_name:"Function" child_links:<child_index:9 > child_links:<child_index:10 > short_representation:<description:"($ItemID = @itemid)" > index:9 kind:SCALAR display_name:"Reference" short_representation:<description:"$ItemID" > index:10 kind:SCALAR display_name:"Parameter" short_representation:<description:"@itemid" > metadata:<fields:<key:"name" value:<string_value:"itemid" > > fields:<key:"type" value:<string_value:"scalar" > > > index:11 kind:SCALAR display_name:"Function" child_links:<child_index:12 > child_links:<child_index:13 > short_representation:<description:"($ItemType = @itemtype)" > index:12 kind:SCALAR display_name:"Reference" short_representation:<description:"$ItemType" > index:13 kind:SCALAR display_name:"Parameter" short_representation:<description:"@itemtype" > metadata:<fields:<key:"name" value:<string_value:"itemtype" > > fields:<key:"type" value:<string_value:"scalar" > > > index:14 kind:SCALAR display_name:"Function" child_links:<child_index:8 > child_links:<child_index:11 > short_representation:<description:"($ItemID = @itemid) AND ($ItemType = @itemtype)" > index:15 kind:SCALAR display_name:"Parameter" short_representation:<description:"@itemid" > metadata:<fields:<key:"name" value:<string_value:"itemid" > > fields:<key:"type" value:<string_value:"scalar" > > > index:16 kind:SCALAR display_name:"Parameter" short_representation:<description:"@itemtype" > metadata:<fields:<key:"name" value:<string_value:"itemtype" > > fields:<key:"type" value:<string_value:"scalar" > > > index:17 kind:SCALAR display_name:"Reference" short_representation:<description:"$Name" > index:18 kind:SCALAR display_name:"Function" child_links:<child_index:19 > child_links:<child_index:22 > short_representation:<description:"(($ItemID = @itemid) AND ($ItemType = @itemtype))" > index:19 kind:SCALAR display_name:"Function" child_links:<child_index:20 > child_links:<child_index:21 > short_representation:<description:"($ItemID = @itemid)" > index:20 kind:SCALAR display_name:"Reference" short_representation:<description:"$ItemID" > index:21 kind:SCALAR display_name:"Parameter" short_representation:<description:"@itemid" > metadata:<fields:<key:"name" value:<string_value:"itemid" > > fields:<key:"type" value:<string_value:"scalar" > > > index:22 kind:SCALAR display_name:"Function" child_links:<child_index:23 > child_links:<child_index:24 > short_representation:<description:"($ItemType = @itemtype)" > index:23 kind:SCALAR display_name:"Reference" short_representation:<description:"$ItemType" > index:24 kind:SCALAR display_name:"Parameter" short_representation:<description:"@itemtype" > metadata:<fields:<key:"name" value:<string_value:"itemtype" > > fields:<key:"type" value:<string_value:"scalar" > > >QueryWithStats

QueryWithStats()を使用することで、クエリの実行統計を取得できます。(RowIteratorのNext()がDoneを返した後に使用できます。)また、AnalyzeQuery()同様にQueryPlanフィールドで実行計画も取得できます。

func ReadOnlyTxQueryWithStats(ctx context.Context, client *spanner.Client) error { rtx := client.ReadOnlyTransaction() defer rtx.Close() sql := `SELECT ItemID, ItemType, Name FROM Item WHERE ItemID = @ItemID AND ItemType = @ItemType` params := map[string]interface{}{ "ItemID": 2, "ItemType": "Type3", } iter := rtx.QueryWithStats(ctx, spanner.Statement{SQL: sql, Params: params}) defer iter.Stop() for { row, err := iter.Next() if err == iterator.Done { break } if err != nil { return err } var itemID int64 var itemType, name string if err := row.Columns(&itemID, &itemType, &name); err != nil { return err } fmt.Printf("%d %s %s\n", itemID, itemType, name) } // クエリの実行統計 for k, v := range iter.QueryStats { fmt.Printf("%s: %v\n", k, v) } // 実行計画も取得できる(省略) // fmt.Printf("QueryPlan: %v\n", iter.QueryPlan) return nil }# 出力結果 2 Type3 アイテム7 elapsed_time: 4.25 msecs data_bytes_read: 0 query_text: SELECT ItemID, ItemType, Name FROM Item WHERE ItemID = @ItemID AND ItemType = @ItemType rows_returned: 1 filesystem_delay_seconds: 0 msecs query_plan_creation_time: 2.34 msecs deleted_rows_scanned: 0 bytes_returned: 30 cpu_time: 2.34 msecs remote_server_calls: 0/0 rows_scanned: 1 runtime_creation_time: 0 msecsSingle

Single()を使用することで明示的にReadOnlyTransaction()を実行せずとも、テンポラリなトランザクション上でクエリを実行できます。単一の検索クエリを投げるだけであればこちらの方が簡単に使用できます。

func ReadOnlyTxSingleQuery(ctx context.Context, client *spanner.Client) error { sql := `SELECT ItemID, ItemType, Name FROM Item WHERE ItemID = @ItemID AND ItemType = @ItemType` params := map[string]interface{}{ "ItemID": 2, "ItemType": "Type3", } iter := client.Single().Query(ctx, spanner.Statement{SQL: sql, Params: params}) defer iter.Stop() for { row, err := iter.Next() if err == iterator.Done { break } if err != nil { fmt.Println(err) return err } var itemID int64 var itemType, name string if err := row.Columns(&itemID, &itemType, &name); err != nil { return err } fmt.Printf("%d %s %s\n", itemID, itemType, name) } return nil }# 出力結果 2 Type3 アイテム7WithTimestampBound

Spannerの読み取り時に使用するタイムスタンプには、次の3つのモードが存在します。(デフォルトはStrong reads)

- Strong reads(最新データを読み取り)

- Exact staleness(指定タイムスタンプより古くないデータを読み取り)

- Bounded staleness(指定タイムスタンプと一致するデータを読み取り)

WithTimestampBound()を用いて、トランザクション内での読み取りモードを指定することができます。(この指定は主に、マルチリージョンで効果を発揮します。)

func ReadOnlyTxQueryWithTimestampBound(ctx context.Context, client *spanner.Client) error { rtx := client.ReadOnlyTransaction() defer rtx.Close() sql := `SELECT ItemID, ItemType, Name FROM Item WHERE ItemID = @ItemID AND ItemType = @ItemType` params := map[string]interface{}{ "ItemID": 2, "ItemType": "Type3", } iter := rtx.WithTimestampBound(spanner.ExactStaleness(15*time.Second)).Query(ctx, spanner.Statement{SQL: sql, Params: params}) defer iter.Stop() for { row, err := iter.Next() if err == iterator.Done { break } if err != nil { return err } var itemID int64 var itemType, name string if err := row.Columns(&itemID, &itemType, &name); err != nil { return err } fmt.Printf("%d %s %s\n", itemID, itemType, name) } return nil }# 出力結果 2 Type3 アイテム7Timestamp

Timestamp()を実行すると、トランザクションにおけるタイムスタンプを取得できます。

タイムスタンプはクエリの実行後に取得可能です。func ReadOnlyTxTimestamp(ctx context.Context, client *spanner.Client) error { rtx := client.ReadOnlyTransaction() defer rtx.Close() t, _ := rtx.Timestamp() fmt.Println("Timestamp: ", t) sql := `SELECT ItemID, ItemType, Name FROM Item WHERE ItemID = @ItemID AND ItemType = @ItemType` params := map[string]interface{}{ "ItemID": 2, "ItemType": "Type3", } iter := rtx.Query(ctx, spanner.Statement{SQL: sql, Params: params}) defer iter.Stop() for { row, err := iter.Next() if err == iterator.Done { break } if err != nil { return err } var itemID int64 var itemType, name string if err := row.Columns(&itemID, &itemType, &name); err != nil { return err } fmt.Printf("%d %s %s\n", itemID, itemType, name) } iter = rtx.WithTimestampBound(spanner.ExactStaleness(15*time.Second)).Query(ctx, spanner.Statement{SQL: sql, Params: params}) t, _ = rtx.Timestamp() fmt.Println("Timestamp: ", t) return nil }# 出力結果 Timestamp: 0001-01-01 00:00:00 +0000 UTC 2 Type3 アイテム7 Timestamp: 2019-12-19 20:57:24.615294 +0900 JSTまとめ

今回はGoのSpannerクライアントでReadOnlyTransactionを扱う方法をまとめました。

ReadWriteTransactionの読み取り処理も、ReadOnlyTransactionを埋め込んで実装されているので、今回のポイントを抑えておけば問題なく使用できると思います。また機会があれば、ReadWriteTransactionの書き込み処理についても触れたいと思います。

最後までお付き合いいただきありがとうございました。

- 投稿日:2019-12-18T22:38:57+09:00

AWSを使ってサーバーレスにRestAPIを作ってみた。

DeNA20新卒アドベントカレンダー23日目です。

サーバーレス

サーバーレスアーキテクチャーがここ最近だいぶ浸透してきたと思います。

サーバーレスと言っても実際にはサーバーはクラウド上にあり、その上でプログラムやコンテナを走らせるのですが、

面倒な(そしてある意味楽しい)サーバーの保守から解放されて、よりアプリケーションそのものに集中できるようになったのは開発者として嬉しいポイントです。

また、他のマネージドサービスとの連携も容易で低いコストでウェブアプリケーションが作れるようになりました。

今回はAWSを使ってサーバーレスに掲示板Rest APIを作ってみました。ちなみにRestではなくGraphQLを使うのも考えましたが、学習が間に合わずに断念…

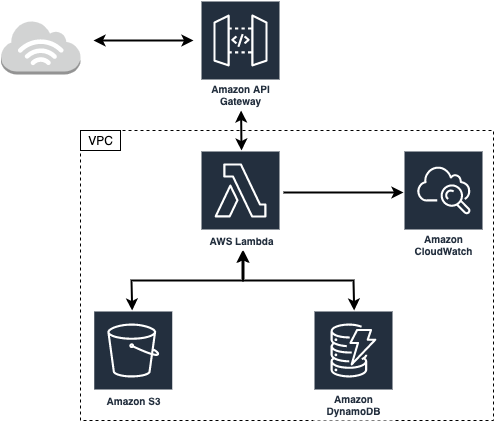

ちなみに元々掲示板のサーバーサイドだけを作って、各種APIを公開して各々のユーザーがクライアントを作ると言うコンセプトの下にAPIを作っていました。やっていくうちに色々と知見がたまったので公開すると言うのがこの記事の主旨になります。作成するAPIの構成は以下のようになります。

本当はS3を使って画像のアップロードもできるようにしたかったけど間に合いませんでした。AWS Lambda

AWS Lambdaはクラウド上でプログラムを走らせるためのサービスです。

リクエストごとに料金がかかる仕組みですが、無料分が非常に大きく並大抵のリクエスト程度ならタダで使えます。

ちなみに少し前に流行った最弱AIオセロはAWS Lambdaで動いていました。(C++のプログラムをスタティックビルドして盤面情報をコマンドライン引数としてPythonのsubprocessで動かすと言う力技)今回はバックエンドのロジックを全てLambdaを使用して実装しました。

AWS Lambdaでは現在Node.js, Python, Ruby, Java, Go, C#が使えるようですが、今回は自身の練習を兼ねてGoで実装しました。Dynamo DB

データベースにはDynamoDBを使用しています。普段MySQLばかりでNoSQLのデータベースを使ってみたいと言う理由で使いましたが、スケールが容易だったり料金が安いなどのメリットが多い一方、なかなかに癖が強く慣れるのに時間がかかりました。DynamoDBではパーティションキー、もしくはパーティションキーとレンジキーのセットがプライマリキー(=ユニーク)となるのですが、複数のデータを持ってくるような場合はただ一つのパーティションキーとレンジキーによる範囲指定が必要になります。この時、レンジキーによる範囲指定を行うと出力されるデータは自動的に降順もしくは昇順でソートされます。つまり複数のデータを取得する際は同じパーティションキーを持つデータに対して、レンジキーで範囲を指定するが、パーティションキーとレンジキーはユニークになっている必要があることになります。これらの制約のせいでテーブル設計がなかなか難しく、作り直しを何回か行う羽目になりました。

今回の掲示板APIによるデータベースの操作をまとめると以下のようになります。

- スレッド一覧の取得(スレッドの一覧は更新された時間順に100件までとする。)

- スレッドの投稿

- あるスレッドのレスポンスの取得(レスポンスの一覧は投稿順とする。)

- レスポンスの投稿(スレッドの最終更新時間を更新する。)

従ってスレッドは全て同じパーティションキー、更新時間をレンジキーとしたいのですが、パーティションキーとレンジキーのセットのユニーク性を考えると、パーティションキーが同じであればレンジキーによってのみユニーク性が担保される必要性が出てきます。しかし更新時間がユニークなのはあまり綺麗な実装とは言えない気がするので別のテーブルを考えます。ちなみにスキャンをすることで全データの摘出ができ、それらについてフィルターをかける方法もありますが、テーブルの要素が多くなることはあっても減ることはないのでできる限り避けたいところです。データ転送量で課金なことを考えるとコスト的にもなしです。

DynamoDBでは基本的にパーティションキーとレンジキーの組み合わせでデータを取得しますが、ローカルセカンダリインデックス(LSI)やグローバルセカンダリインデックス(GSI)を追加することで、同じテーブルについて異なるキーで検索をかけることができます。LSIでは同じパーティションキーについてレンジキー相当のキーの追加、GSIではパーティションキー相当のキーとレンジキー相当のキーの追加が可能ですが、内部実装的にはテーブルを複製しているらしいのでDynamoDBのコストとの相談が必要です。ここでキー相当と表現したのは、LSIについては追加したレンジキー相当のキーと既存のパーティションキーとの組み合わせがユニークでなくても良く、GSIについては追加したキー二つがユニークでなくても良いためです。ちなみにテーブルへのLSIの追加はテーブル作成時にしかできないので注意してください。

今回の要件を考えると更新時間をLSIに追加すれば更新時間によるスレッド一覧の取得が可能になります。するとレンジキーは実質スレッドをユニークにするためだけに存在するので、邪道な気もしますがこれをRDBにおけるプライマリキーと見なすことにしました。ただし、DynamoDBではRDSにおけるAuto Incrementのようなオプションは存在しない(できないことはないが別途インデックスを管理するテーブルが必要になる。)のでUUIDを使用し、このUUIDをプライマリキーとしてスレッドに対するレスポンステーブルを作成しました。

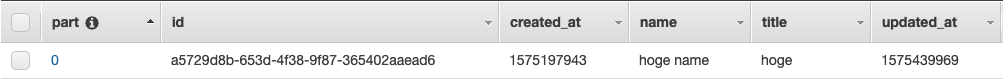

threadsテーブル

partをパーティションキー、idをレンジキー、updated_atをLSIとしています。

パーティションキーであるpartが全てのスレッドについて0で、毎回のリクエストでパーティションキーに0を入れるのは設計としてどうなんだと言う気もしますが

実際にDynamoDBのドキュメントにディスカッションフォーラムにおけるテーブル設計の例があります。

https://docs.aws.amazon.com/ja_jp/amazondynamodb/latest/developerguide/SampleData.CreateTables.html

このページのthreadテーブルを見てみるとプライマリキーがフォーラム名となっています。プライマリキーをフォーラム名とかカテゴリ名として掲示板を分けていくとすれば、今回の例ではフォーラムが一つしかない場合と考えられるので、そこまで変な実装でもないのかなと言う気がします。規模が大きくなればパーティションキーを1, 2...と増やしていきパーティションキーごとに掲示板を分けていけば、負荷的にも問題ないと思われます。responsesカラムにはDynamoDB用に変換されたjsonオブジェクトが入っています。

クエリでデータを取り出す際に取り出すカラムを指定できるので、今回の場合はスレッドのデータにそのままレスポンスのデータをくっつけるのもアリだと思いますが、上記のAWSのサンプルに則って分けました。Goの実装

LambdaでGoを使いdynamodbにアクセスするにはSDKが必要です。

必要なものだけをインストールしてもいいのですが、面倒なので下記コマンドでまとめてAWS用のGoSDKをインストールしました。

go get github.com/aws/aws-sdk-go/...LambdaでGoを使うにあたって必要なパッケージはaws-lambda-go/eventsとaws-lambda-go/lambdaになります。

前者がLambdaへの各種データの入出力を扱うパッケージ、後者がlambdaを実行するためのパッケージになっているようです。

GoでLambdaを動かす解説サイトがあまりないので割とドキュメントと睨めっこが多くなるかもしれません。https://godoc.org/github.com/aws/aws-lambda-go/lambda

https://godoc.org/github.com/aws/aws-lambda-go/eventsGoのmain関数でハンドラー関数をlambdaで実行すると言う命令を出します。

下のような定型文を書けばあとはLambdaがよしなにしてくれるので、ハンドラー関数の方で受け取ったデータを処理して返すと言うのが一連の流れです。func main() { lambda.Start(handler) }データの受け取り

データはAPI Gatewayから渡されますが、この時データがどう渡されるかによって処理の書き方が異なります。

getでデータを渡す場合、API Gatewayを通す時にURL文字列を処理する必要があります。

API Gatewayからは以下のような構造体のデータがハンドラ関数に送られます。type APIGatewayProxyRequest struct { Resource string `json:"resource"` // The resource path defined in API Gateway Path string `json:"path"` // The url path for the caller HTTPMethod string `json:"httpMethod"` Headers map[string]string `json:"headers"` MultiValueHeaders map[string][]string `json:"multiValueHeaders"` QueryStringParameters map[string]string `json:"queryStringParameters"` MultiValueQueryStringParameters map[string][]string `json:"multiValueQueryStringParameters"` PathParameters map[string]string `json:"pathParameters"` StageVariables map[string]string `json:"stageVariables"` RequestContext APIGatewayProxyRequestContext `json:"requestContext"` Body string `json:"body"` IsBase64Encoded bool `json:"isBase64Encoded,omitempty"` }この時何かしらのデータが、パスパラメータもしくはクエリ文字列として渡されていた場合

前者であればPathParameters

後者であればQueryStringParameters

にそれぞれmapで入っています。

クエリ文字列であれば単純ですが、パスパラメータの場合はAPI Gatewayの方でマッピングを行う必要です。

今回はどちらでも受け取れるようにしました。postでデータを渡す場合、jsonで渡していればそのままハンドラー関数の引数にjsonが入ってくるので、適当な構造体を用意しておけばそのままデータが使えます。

例えば以下のような構造体で表せるjsonデータを渡す場合type Request struct { ThreadID string `json:"id"` Name string `json:"name"` Content string `json:"content"` }ハンドラー関数では以下のように中身が参照できます。

func handler(request Request) { name := request.Name threadID := request.ThreadID content := request.Content }jsonでデータを受け取る際は、API Gatewayがそのままデータを渡してくれるので簡潔に受け取ることができます。

events.APIGatewayProxyRequest型で受け取ってもBodyにデータが入っていると思われますが、string型で入ってくるので別途構造体に変換する必要があります。

ちなみにlambda上でプログラムの実行テストができますが、eventsを使ったパラメータの受け取りはAPI Gatewayを介していないためエラーが発生します。

jsonによるデータの受け渡しテストを行なってからAPI Gateway用に書き換える手間が発生するので、getでもjsonでデータを渡すようにする方が楽かもしれません。データの返却

API Gatewayを通してデータを送るにはevents.APIGatewayProxyResponse型のデータを返す必要があります。

type APIGatewayProxyResponse struct { StatusCode int `json:"statusCode"` Headers map[string]string `json:"headers"` MultiValueHeaders map[string][]string `json:"multiValueHeaders"` Body string `json:"body"` IsBase64Encoded bool `json:"isBase64Encoded,omitempty"` }この中でStatusCodeとHeadersはAPI Gatewayを通してデータを返却するためには必須です。

StatusCodeはhttpパッケージのものを利用すれば大丈夫です。

HeadersはCORSを行うために'Access-Control-Allow-Originを適切に設定する必要があります。以下が実際に実装したコードです。

githubはこちら

GoでdynamoDBを操作していますが、これについて詳しく解説すると記事が丸々一本書けそうなので割愛します。

一応はAWSのドキュメントを読めばできますが、ハマるポイントも多く結構苦戦しました。質問があればコメント欄に書いてもらえればできる限り調査します。スレッド一覧の取得

get_threads.gopackage main import ( "encoding/json" "net/http" "github.com/aws/aws-lambda-go/events" "github.com/aws/aws-lambda-go/lambda" "github.com/aws/aws-sdk-go/aws" "github.com/aws/aws-sdk-go/aws/session" "github.com/aws/aws-sdk-go/service/dynamodb" "github.com/aws/aws-sdk-go/service/dynamodb/dynamodbattribute" ) // スレ用の構造体 type Thread struct { ID string `json:"id"` Title string `json:"title"` CreatedAt int64 `json:"created_at"` UpdatedAt int64 `json:"updated_at"` } type Threads struct { Threads []Thread } // レス用の構造体 type Response struct { Threads []Thread `json:"body"` } // 何かしらエラーが発生した場合internal server errorを返す。 func internalServerError() (events.APIGatewayProxyResponse, error) { return events.APIGatewayProxyResponse{ StatusCode: http.StatusInternalServerError, Headers: map[string]string{ "Access-Control-Allow-Origin": "*", }, }, nil } // ハンドラー関数、スレッド一覧は何も受け取らない。データベースから取得したスレッド一覧のみ返却する。 func Handler() (interface{}, error) { // awsとのsession作成、失敗すればinternal server error sess, err := session.NewSession() if err != nil { return internalServerError() } // セッションを使ってdynamoDBを利用する svc := dynamodb.New(sess) // dynamoDB用のqueryの作成 getQuery := &dynamodb.QueryInput{ // テーブル名(そのまま) TableName: aws.String("threads"), // インデックスを使用する場合はインデックス名 IndexName: aws.String("part-updated_at-index"), // カラムに別名をつける ExpressionAttributeNames: map[string]*string{ "#part": aws.String("part"), }, // カラムの値に別名をつける ExpressionAttributeValues: map[string]*dynamodb.AttributeValue{ ":part": { N: aws.String("0"), }, }, // 先ほどつけた別名を使って、プライマリキーを指定する KeyConditionExpression: aws.String("#part = :part"), // カラムのどの値を取得するかの指定 ProjectionExpression: aws.String("id, title, created_at, updated_at"), // レンジキーによるソート、昇順か降順か ScanIndexForward: aws.Bool(false), // 取得するデータ数の上限 Limit: aws.Int64(100), } // 上で定義したクエリを使って、データを取り出す。失敗すればinternal server error result, err := svc.Query(getQuery) if err != nil { return internalServerError() } // データが取り出せた場合、スレッドの一覧(=リスト)なのでそれを入れるためのThreadスライスを作成する threads := make([]Thread, 0) // 各々のスレッドは先ほどProjectionExpressionで指定したようにid, title, created_at, updated_atを持つオブジェクト // そしてそれがリストになっている(=ListOfMaps)が、この取り出したデータはDynamoDB用のフォーマットになっている。 // DynamoDBのデータフォーマットについてはhttps://docs.aws.amazon.com/ja_jp/amazondynamodb/latest/developerguide/Programming.LowLevelAPI.html // UnmarshalListOfMapsでスレッド構造体のスライスに入れられるようにデータを変換する。 if err := dynamodbattribute.UnmarshalListOfMaps(result.Items, &threads); err != nil { return internalServerError() } // json型に変換、失敗すればinternal server error jsonBody, err := json.Marshal(threads) if err != nil { return internalServerError() } // 取得したデータをjsonで返却する。 // originが異なるためAccess-Control-Allow-Originを付与 // 今回はコンセプトのために*にしているが、実際の場面では適切に設定してください。 return events.APIGatewayProxyResponse{ Body: string(jsonBody), StatusCode: http.StatusOK, Headers: map[string]string{ "Access-Control-Allow-Origin": "*", }, }, nil } // lambdaを実行 func main() { lambda.Start(Handler) }スレッドの作成

create_threads.gopackage main import ( "context" "net/http" "time" "github.com/aws/aws-lambda-go/events" "github.com/aws/aws-lambda-go/lambda" "github.com/aws/aws-sdk-go/aws" "github.com/aws/aws-sdk-go/aws/session" "github.com/aws/aws-sdk-go/service/dynamodb" "github.com/aws/aws-sdk-go/service/dynamodb/dynamodbattribute" "github.com/google/uuid" "golang.org/x/sync/errgroup" ) type Request struct { Title string `json:"title"` Name string `json:"name"` Content string `json:"content"` } type response struct { Name string `json:"name"` CreatedAt int64 `json:"created_at"` Content string `json:"content"` } type responses struct { ThreadID string `json:"thread_id"` Responses []response `json:"responses"` } type thread struct { Part int `json:"part"` ID string `json:"id"` Title string `json:"title"` CreatedAt int64 `json:"created_at"` UpdatedAt int64 `json:"updated_at"` Name string `json:"name"` } func internalServerError() (events.APIGatewayProxyResponse, error) { return events.APIGatewayProxyResponse{ StatusCode: http.StatusInternalServerError, Headers: map[string]string{ "Access-Control-Allow-Origin": "*", }, }, nil } // データをデータベースに格納するための関数、タイムアウト処理用のcontextを受け取る。 func insertData(ctx context.Context, svc *dynamodb.DynamoDB, data interface{}, target string) error { // 格納するデータをdynamoDB用に変換 // 中身はただのmapなので手でも作れないことはない av, err := dynamodbattribute.MarshalMap(data) if err != nil { return internalServerError() } // データを格納するためのパラメータ putParams := &dynamodb.PutItemInput{ TableName: aws.String(target), Item: av, } // Timeoutになるか、データの格納が成功するまでループ for { select { case <-ctx.Done(): // タイムアウトした場合はcloudwatchにエラーログを残す return fmt.Errorf("inserting data into the table, %v failed", target) default: _, err = svc.PutItem(putParams) if err != nil { continue } return nil } } return nil } // ハンドラー関数、データをjsonで受け取るため、Request型のrequestを引数にもつ。 func handler(request Request) (events.APIGatewayProxyResponse, error) { name := request.Name title := request.Title content := request.Content sess, err := session.NewSession() if err != nil { return internalServerError() } svc := dynamodb.New(sess) // スレッドのIDをuuidv4で作成する threadID := uuid.New().String() // threadsテーブルに格納するデータの構造体 t := thread{ Part: 0, ID: threadID, Title: title, Name: name, CreatedAt: time.Now().Unix(), UpdatedAt: time.Now().Unix(), } // responsesテーブルに格納するデータの構造体 r := responses{ ThreadID: threadID, Responses: []response{ response{ Name: name, CreatedAt: time.Now().Unix(), Content: content, }, }, } // 上記二テーブルへのデータの格納はgoroutineで並列に実行 // goroutineでエラーを扱うためにerrgroupを使用 // タイムアウトしたらinternal server error eg, ctx := errgroup.WithContext(context.Background()) ctx, cancel := context.WithTimeout(ctx, 2*time.Second) defer cancel() eg.Go(func() error { return insertData(ctx, svc, t, "threads") }) eg.Go(func() error { return insertData(ctx, svc, r, "responses") }) if err := eg.Wait(); err != nil { return internalServerError() } // データの格納が完了 return events.APIGatewayProxyResponse{ StatusCode: http.StatusOK, Headers: map[string]string{ "Access-Control-Allow-Origin": "*", }, }, nil } func main() { lambda.Start(handler) }レス一覧の取得

get_responses.gopackage main import ( "encoding/json" "net/http" "github.com/aws/aws-lambda-go/events" "github.com/aws/aws-lambda-go/lambda" "github.com/aws/aws-sdk-go/aws" "github.com/aws/aws-sdk-go/aws/session" "github.com/aws/aws-sdk-go/service/dynamodb" "github.com/aws/aws-sdk-go/service/dynamodb/dynamodbattribute" "reflect" ) type Request struct { ThreadID string `json:"id"` } type Response struct { Responses interface{} `json:"body"` } func internalServerError() (events.APIGatewayProxyResponse, error) { return events.APIGatewayProxyResponse{ StatusCode: http.StatusInternalServerError, Headers: map[string]string{ "Access-Control-Allow-Origin": "*", }, }, nil } // 取得するレスのIDをクエリパラメータもしくパスパラメータで受け取るため、events.APIGatewayProxyRequest型の引数を持つ。 func Handler(request events.APIGatewayProxyRequest) (interface{}, error) { // パスパラメータかクエリでスレのidを取得する。なければStatusBadRequest var id string if tmp, ok := request.PathParameters["id"]; ok == true { id = tmp } else if tmp, ok := request.QueryStringParameters["id"]; ok == true { id = tmp } else { return events.APIGatewayProxyResponse{ StatusCode: http.StatusBadRequest, Headers: map[string]string{ "Access-Control-Allow-Origin": "*", }, }, nil } sess, err := session.NewSession() if err != nil { return internalServerError() } svc := dynamodb.New(sess) // 今回は一つのデータを取得するのでGetItemInput型 getItemInput := &dynamodb.GetItemInput{ TableName: aws.String("responses"), // 単純なオブジェクトなので手でDynamoDBのフォーマットにする // もちろんMarshal関数を使って作ってもいい Key: map[string]*dynamodb.AttributeValue{ "thread_id": { S: aws.String(id), }, }, } result, err := svc.GetItem(getItemInput) if err != nil { return internalServerError() } // 返ってくるデータに合う構造体を作るのが面倒なのでinterface{}に入れてしまう // 今回は単一のオブジェクトなのでUnmarshalMap関数を使用する var responses interface{} if err := dynamodbattribute.UnmarshalMap(result.Item, &responses); err != nil { return internalServerError() } // 中身がjsonで、キーが何なのかもわかっているので、reflectパッケージを使って中身を取り出す rv := reflect.ValueOf(responses) res := rv.MapIndex(reflect.ValueOf("responses")).Interface() // 取り出した中身をjsonに変換する。失敗したらinternal server error jsonBody, err := json.Marshal(res) if err != nil { return internalServerError() } return events.APIGatewayProxyResponse{ Body: string(jsonBody), StatusCode: http.StatusOK, Headers: map[string]string{ "Access-Control-Allow-Origin": "*", }, }, nil } func main() { lambda.Start(Handler) }レスの追加

put_response.gopackage main import ( "context" "fmt" "net/http" "time" "github.com/aws/aws-lambda-go/events" "github.com/aws/aws-lambda-go/lambda" "github.com/aws/aws-sdk-go/aws" "github.com/aws/aws-sdk-go/aws/session" "github.com/aws/aws-sdk-go/service/dynamodb" "github.com/aws/aws-sdk-go/service/dynamodb/dynamodbattribute" "golang.org/x/sync/errgroup" ) type Request struct { ThreadID string `json:"id"` Name string `json:"name"` Content string `json:"content"` } type Response struct { Name string `json:"name"` CreatedAt int64 `json:"created_at"` Content string `json:"content"` } type UpdatedAt struct { UpdatedAt int64 `json:"updated_at"` } func internalServerError() (events.APIGatewayProxyResponse, error) { return events.APIGatewayProxyResponse{ StatusCode: http.StatusInternalServerError, Headers: map[string]string{ "Access-Control-Allow-Origin": "*", }, }, nil } func updateData(ctx context.Context, svc *dynamodb.DynamoDB, data *dynamodb.UpdateItemInput) error { // 同じくタイムアウトまでデータの格納を試みる for { select { case <-ctx.Done(): return fmt.Errorf("Update data in the table, %v failed", aws.StringValue(data.TableName)) default: _, err := svc.UpdateItem(data) if err != nil { continue } return nil } } } func handler(req Request) (events.APIGatewayProxyResponse, error) { now := time.Now().Unix() sess, err := session.NewSession() if err != nil { return internalServerError() } svc := dynamodb.New(sess) r := []Response{Response{ Name: req.Name, CreatedAt: now, Content: req.Content, }} threadID := req.ThreadID response, err := dynamodbattribute.Marshal(r) if err != nil { return internalServerError() } // レスの追加は、データの更新にあたるのでUpdateItem rInputParams := &dynamodb.UpdateItemInput{ TableName: aws.String("responses"), Key: map[string]*dynamodb.AttributeValue{ "thread_id": {S: aws.String(threadID)}, }, // dynamoDBでのリストへの追加はlist_append関数を使う。第一引数に第二引数を追加したリストを返却するのでそれをそのままSETする UpdateExpression: aws.String("SET #ri = list_append(#ri, :vals)"), // 多分名前をつけた方がいい ExpressionAttributeNames: map[string]*string{ "#ri": aws.String("responses"), }, // 同上 ExpressionAttributeValues: map[string]*dynamodb.AttributeValue{ ":vals": response, }, } updatedAt, err := dynamodbattribute.Marshal(now) if err != nil { return internalServerError() } tInputParams := &dynamodb.UpdateItemInput{ TableName: aws.String("threads"), Key: map[string]*dynamodb.AttributeValue{ "part": {N: aws.String("0")}, "id": {S: aws.String(threadID)}, }, // 単純な値の上書きはSET a = bでできる UpdateExpression: aws.String("SET #ri = :vals"), ExpressionAttributeNames: map[string]*string{ "#ri": aws.String("updated_at"), }, ExpressionAttributeValues: map[string]*dynamodb.AttributeValue{ ":vals": updatedAt, }, } eg, ctx := errgroup.WithContext(context.Background()) ctx, cancel := context.WithTimeout(ctx, 2*time.Second) defer cancel() eg.Go(func() error { return updateData(ctx, svc, rInputParams) }) eg.Go(func() error { return updateData(ctx, svc, tInputParams) }) if err := eg.Wait(); err != nil { return internalServerError() } return events.APIGatewayProxyResponse{ StatusCode: 200, Headers: map[string]string{ "Access-Control-Allow-Origin": "*", }, }, nil } func main() { lambda.Start(handler) }AWS Lambdaでプログラムを実行するためには、実行したいファイルをzip形式でアップロード、もしくはウェブ上のエディタで直接コードを編集する必要があります。

Goに関しては前者しかできないようなので、これらのプログラムをまとめてコンパイルしてzipにするMakefileもついでに作成しました。all: get_threads.zip create_thread.zip get_responses.zip put_response.zip get_threads: get_threads.go GOOS=linux GOARCH=amd64 go build get_threads.go create_thread: create_thread.go GOOS=linux GOARCH=amd64 go build create_thread.go get_responses: get_responses.go GOOS=linux GOARCH=amd64 go build get_responses.go put_response: put_response.go GOOS=linux GOARCH=amd64 go build put_response.go get_threads.zip: get_threads zip $@ $< create_thread.zip: create_thread zip $@ $< get_responses.zip: get_responses zip $@ $< put_response.zip: put_response zip $@ $< clean: rm get_threads create_thread get_responses put_response *.zip完成した4つのバイナリのzipファイルを4つのAWS Lambdaの関数に登録すればLambda側の準備は完了です。

zipは関数コードのパネルからアップロードできます。

ハンドラには実行するファイル名を入力します。ここではget_threads.goをget_threadsにコンパイルしてget_threads.zipにしたものをアップロードしました。

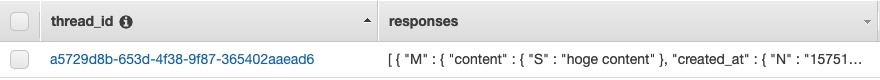

API Gateway

AWS Lambdaはそのままだとhttpのリクエストをトリガーに発火できないため、リバースプロキシとしてAPI Gatewayを設置してそちらにアクセスされた場合にAWS Lambdaの特定の関数を発火させます。

また、この時パラメータをAWS Lambdaに渡すように設定する必要があります。

補足として、外部からのリクエストを受け付ける際はURLのオリジンが異なるためCORSを有効化する必要があります。現在はRest APIを作ると言う名目(=不特定多数からのアクセスを想定)のため制限はかけていませんが、実際のアプリケーションに組み込む際は適宜設定することをお勧めします。

ちなみに今回のAPIは不特定多数からのアクセスを想定してはいますが、悪戯されても嫌なのでスロットリングを有効化してレートとバーストに制限をかけています。

API Gatewayについての説明はたくさんあるので、省略気味に紹介します。

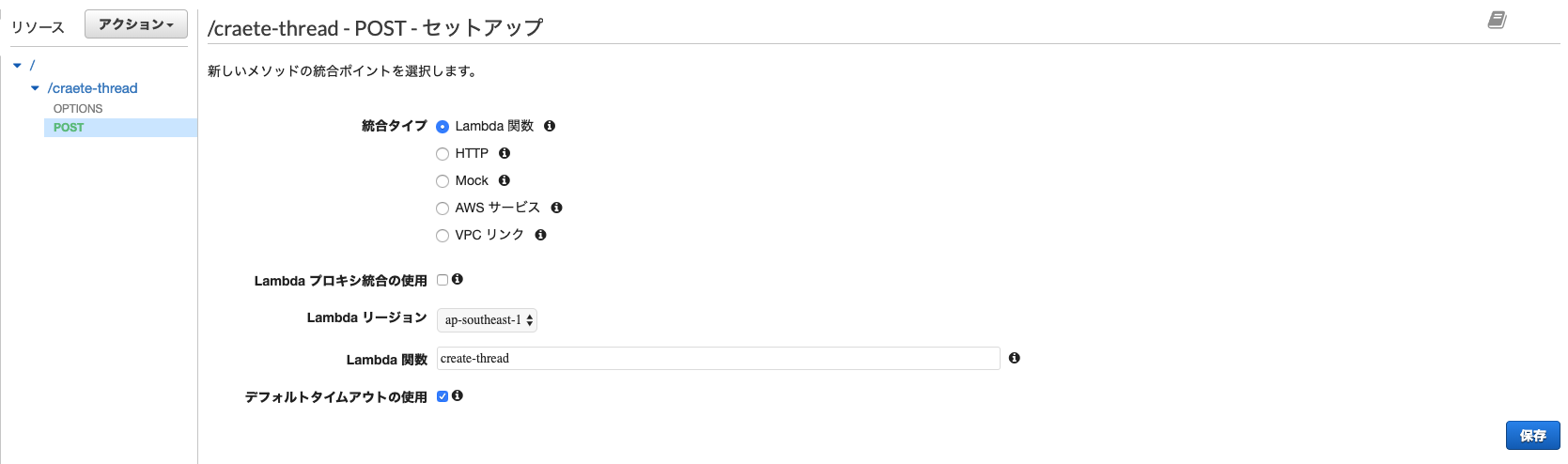

ルート直下に試しにcreate-threadのAPIを作成します。

まずリソース作成で適当なリソース名(今回はcreate-thread)を入力し、API Gateway CORS を有効にします。

これでOPTIONSメソッドが自動的に作られます。

次にメソッド作成ですが、ここで使用するlambdaの関数を選択します。

ここで、Lambda プロキシ統合の使用にチェックを入れるかどうかですが、これはevents.APIGatewayProxyRequestでデータを受け渡ししたい場合はチェックを入れてください。

今回はcreate-thread, put-responseについてはjsonでデータを渡すだけでいいのでチェックせず、get-responsesについてはAPI Gatewayを通してパスパラメータを渡したいのでチェックを入れています。

get-threadsは何もデータを渡さないのでどちらでも問題ありません。

いずれにせよ全てのデータをevents.APIGatewayProxyRequestで受け取るならば全部チェックで問題ありません。

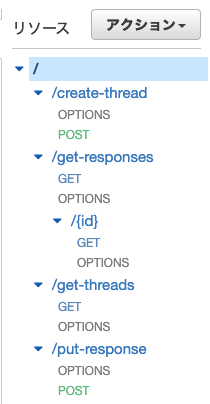

出力については、とりあえずevents.APIGatewayProxyResponse型で返せばいい感じにAPI Gatewayの方で流してくれるみたいです。各種設定を終えると以下のようになります。

CORSを許可する設定になっていれば各種GETやPOSTなどのメソッドの下にOPTIONSメソッドが追加されます。

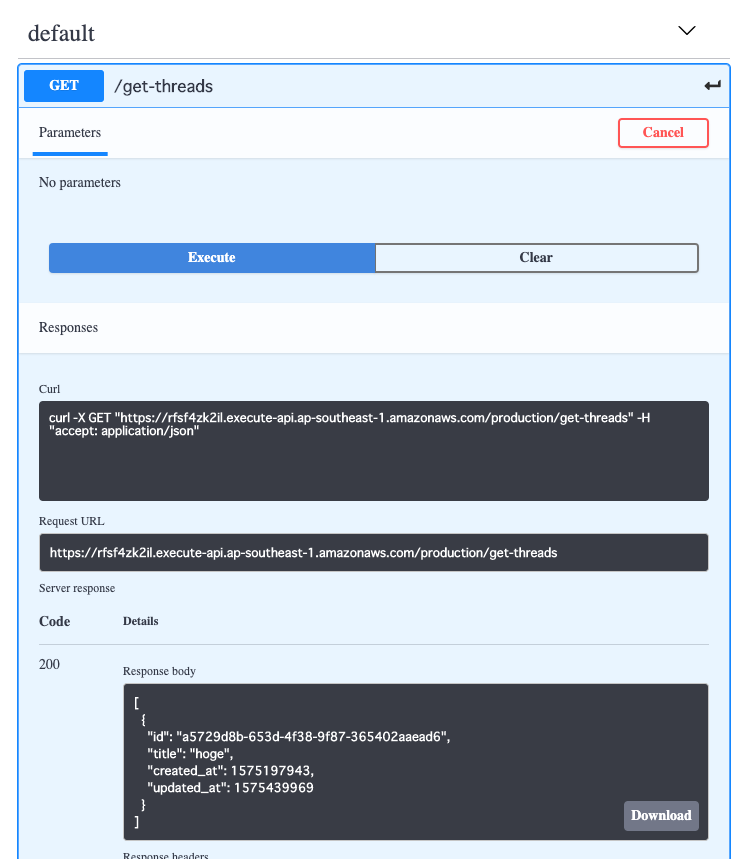

また、パスパラメータの設定ができていれば{id}のようにマッピングが表示されます。Open API

API GatewayではswaggerやOpenAPI3用のjsonやyamlをエクスポートできます。

ここでエクスポートしたファイルをswagger editorなどでインポートするとOpenAPI3でAPIの一覧が見られるようになります。

実際にOpenAPI3上でメソッドの実行もでき、レスポンスが返ってくるのが確認できます。

以上で、掲示板Rest APIが完成しました。

補足

今回はSDKを使ってGoでdynamoDBを操作しましたが、dynamoDBの癖の強さとGoの型ら辺が作用してかなりしんどいです。良い感じに面倒なところやってくれるライブラリがあるみたいなのでそっちを使った方がいいと思います。

https://github.com/guregu/dynamo終わりに

以上でバックエンドの方が完成しました。

~元々のコンセプトとしてはこれでいいのですが、正直バックエンドだけ用意してクライアントは自由に作ってねと言ったところでどうせ誰も作らないので~

ついでにReact Hooks, Redux Hooksが使いたいのもあってReactでクライアントの方も作ろうとしたのですが間に合いませんでした。(某アプリが悪い)

そのうちクライアント側も作って記事公開します。ちなみに実装は素のReactではなくReact staticを使っています。当初はgatsby.jsを使おうとしたのですが

どうもtypescriptで書くには早いかな感と、そもそもgraphQLを使ってないので止めました。

とは言え静的コンテンツとして配信するための静的化ができさえすればよく、肝心のコンテンツは動的に取得するので正直なんでもよかったのですが良い感じにシンプルそうなのでReact staticにしました。

React Hooks, Redux Hooksを使ったコンポーネントの作成やらなんやらはうまくいっているので、あとはcssがうまく書けたら公開になると思います。

- 投稿日:2019-12-18T21:58:53+09:00

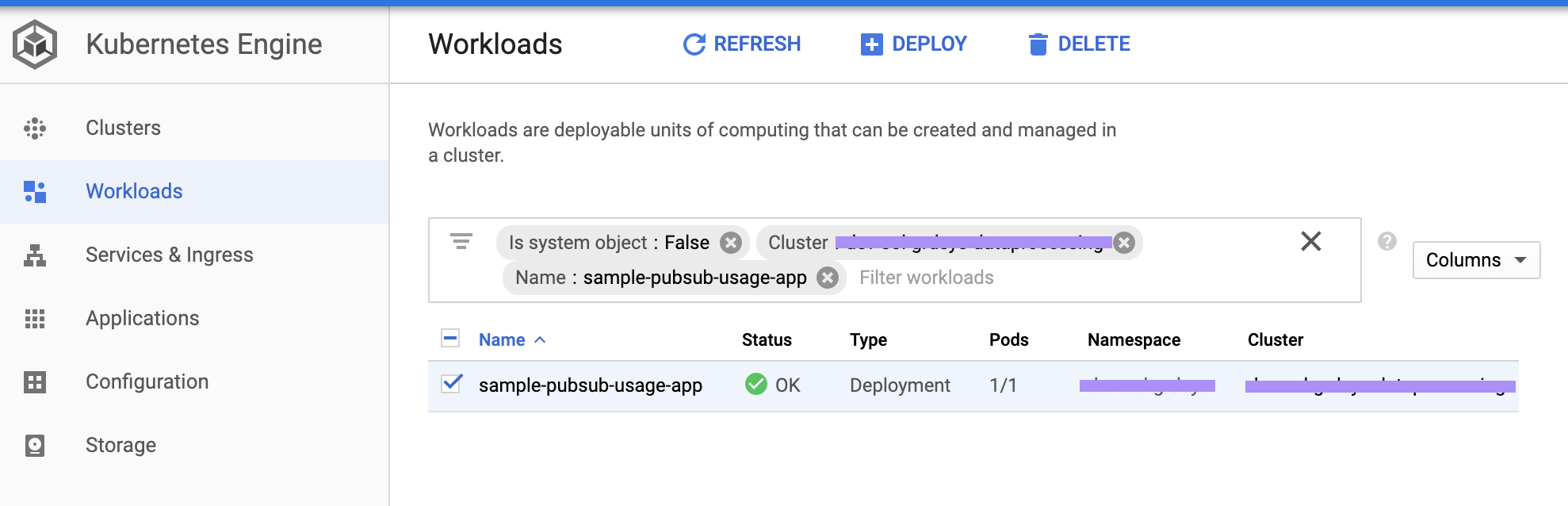

GKE中のGolangアプリケーションからCloud Pub/Subを使ってデータ連携を行う

GKEの中に稼働されるアプリケーションからどうやってGCPサービスにアクセスしたり、データ連携したりするか?という疑問がある方々に回答する記事をまとめました。

Pub/Subサービスを使って、サンプルとして作成しました。手順まとめ

- サービスアカウント作成&アクセス用のaccount.jsonファイル発行

- Pub/SubのTopic&Subscription作成

- Pub/SubをSubscriptionアプリケーションの準備

- ローカルで稼働確認

- Cloudbuildでアプリケーションのイメージビルド

- GKEのCluster準備

- GKEにアプリケーションをデプロイ

- 稼働検証

フォルダ構成

accesspubsub ├── README.md ├── app │ ├── handler │ │ └── sample_handler.go │ └── sample_app.go ├── cloudbuild.sampleapp.yaml ├── deployment.sampleapp.yaml ├── go.mod ├── go.sum ├── sampleapp.Dockerfile ├── secret │ └── account.json └── tool └── publish_to_topic.go1. サービスアカウント作成&アクセス用のaccount.jsonファイル発行

サービスアカウント作成

# set work project gcloud config set project [PROJECT_ID] # create service account gcloud iam service-accounts create service-account \ --display-name "Account using to call GCP service"account.jsonファイル発行

# create service account's credential file gcloud iam service-accounts keys create {{path_to_save/account.json}} \ --iam-account service-account@[PROJECT_ID].iam.gserviceaccount.comサービスアカウント権限付与

本記事は簡単とするため、editorロールを付与します。

# ロールをサービスアカウトに付与。下記のコマンドを実施するため、オーナー権限必要 # editor権限付与 gcloud projects add-iam-policy-binding [PROJECT_ID] \ --member serviceAccount:service-account@[PROJECT_ID].iam.gserviceaccount.com \ --role roles/editorサービスアカウント権限付与について、他の付与方法はこの記事をご参考

GCPのサービスを利用権限のまとめ2. Pub/SubのTopic&Subscription作成

データ連携用のPub/SubのTopicとSubscriptionを作成する。

# Topic作成 gcloud pubsub topics create [TOPIC_NAME] # 例 gcloud pubsub topics create sample-app-topic # Topicのsubscription作成 gcloud pubsub subscriptions create [SUB_NAME] --topic=[TOPIC_NAME] # 例 gcloud pubsub topics create sample-app-topic-sub3. Pub/SubをSubscriptionアプリケーションの準備

sample_app.gopackage main import ( "log" "os" "github.com/itdevsamurai/gke/accesspubsub/app/handler" ) func main() { log.Println("Application Started.") // projectID is identifier of project projectID := os.Getenv("PROJECT_ID") // pubsubSubscriptionName use to hear the comming request pubsubSubscriptionName := os.Getenv("PUBSUB_SUBSCRIPTION_NAME") err := handler.SampleHandler{}.StartWaitMessageOn(projectID, pubsubSubscriptionName) if err != nil { log.Println("Got Error.") } log.Println("Application Finished.") }sample_handler.gopackage handler import ( "context" "fmt" "log" "cloud.google.com/go/pubsub" ) type SampleHandler struct { } // StartWaitMessageOn // projectID := "my-project-id" // subName := projectID + "-example-sub" func (h SampleHandler) StartWaitMessageOn(projectID, subName string) error { log.Println(fmt.Sprintf("StartWaitMessageOn [Project: %s, Subscription Name: %s]", projectID, subName)) ctx := context.Background() client, err := pubsub.NewClient(ctx, projectID) if err != nil { return err } sub := client.Subscription(subName) err = sub.Receive(ctx, processMessage) if err != nil { return err } return nil } // processMessage implement callback function to process received message data var processMessage = func(ctx context.Context, m *pubsub.Message) { log.Println(fmt.Sprintf("Message ID: %s\n", m.ID)) log.Println(fmt.Sprintf("Message Time: %s\n", m.PublishTime.String())) log.Println(fmt.Sprintf("Message Attributes:\n %v\n", m.Attributes)) log.Println(fmt.Sprintf("Message Data:\n %s\n", m.Data)) m.Ack() }このアプリケーションはPub/Subの指定Subscriptionをヒアリングして、メッセージがきたら、処理を行います。

処理はメッセージの内容を印刷するだけのシンプル処理となります。4. ローカルで稼働確認

稼働を検証するため、Pub/SubにメッセージをPublishするツールを準備します。

tool/publish_to_topic.gopackage main import ( "context" "encoding/json" "flag" "fmt" "log" "cloud.google.com/go/pubsub" ) var ( topicID = flag.String("topic-id", "sample-topic", "Specify topic to publish message") projectID = flag.String("project-id", "sample-project", "Specify GCP project you want to work on") ) func main() { flag.Parse() err := publishMsg(*projectID, *topicID, map[string]string{ "user": "Hashimoto", "message": "more than happy", "status": "bonus day!", }, nil) if err != nil { log.Fatalf("Failed to create client: %v", err) } } func publishMsg(projectID, topicID string, attr map[string]string, msg map[string]string) error { // projectID := "my-project-id" // topicID := "my-topic" // msg := message data publish to topic // attr := attribute of message ctx := context.Background() client, err := pubsub.NewClient(ctx, projectID) if err != nil { return fmt.Errorf("pubsub.NewClient: %v", err) } bMsg, err := json.Marshal(msg) if err != nil { return fmt.Errorf("Input msg error : %v", err) } t := client.Topic(topicID) result := t.Publish(ctx, &pubsub.Message{ Data: bMsg, Attributes: attr, }) // ID is returned for the published message. id, err := result.Get(ctx) if err != nil { return fmt.Errorf("Get: %v", err) } fmt.Printf("Published message with custom attributes; msg ID: %v\n", id) return nil }ローカルで稼働検証

# GCPサービスにアクセスためのアカウントJSONファイルを環境変数に設定 # Windowsを使う方は環境変数の設定画面から行ってください。 export GOOGLE_APPLICATION_CREDENTIALS="/path/to/account.json" # アップリケーションを実行 export PROJECT_ID="project-abc123" && \ export PUBSUB_SUBSCRIPTION_NAME="sample-app-topic" && \ go run ./app/sample_app.go # 別のターミナルを開いて、テストツールを実行 # テストのメッセージをTopicにPublishする go run tool/publish_to_topic.go --project-id=project-abc123 --topic-id=sample-app-topic5. Cloudbuildでアプリケーションのイメージビルド

Dockerfile作成

sampleapp.DockerfileFROM alpine:latest RUN apk --no-cache add ca-certificates WORKDIR /app COPY ./sample_app /app ENTRYPOINT ["./sample_app"]Pub/Subにアクセスするため、サービスアカウントのJSONファイルで認証します。

「alpine」イメージのみはライブラリーが足りなくて、認証仕組みはエラーとなります。

「ca-certificates」ライブラリーを追加する必要です。これは注意点となります。cloudbuild.sampleapp.yamloptions: env: - GO111MODULE=on volumes: - name: go-modules path: /go steps: # go test - name: golang:1.12 dir: . args: ['go', 'test', './...'] # go build - name: golang:1.12 dir: . args: ['go', 'build', '-o', 'sample_app', 'app/sample_app.go'] env: ["CGO_ENABLED=0"] # docker build - name: 'gcr.io/cloud-builders/docker' dir: . args: [ 'build', '-t', '${_GCR_REGION}/${_GCR_PROJECT}/${_GCR_IMAGE_NAME}:${_GCR_TAG}', '-f', 'sampleapp.Dockerfile', '--cache-from', '${_GCR_REGION}/${_GCR_PROJECT}/${_GCR_IMAGE_NAME}:${_GCR_TAG}', '.' ] # push image to Container Registry - name: 'gcr.io/cloud-builders/docker' args: ["push", '${_GCR_REGION}/${_GCR_PROJECT}/${_GCR_IMAGE_NAME}'] substitutions: # # Project ID _GCR_PROJECT: project-abc123 # # GCR region name to push image _GCR_REGION: asia.gcr.io # # Image name _GCR_IMAGE_NAME: sample-pubsub-usage-app # # Image tag _GCR_TAG: latestアプリケーションのイメージビルド。

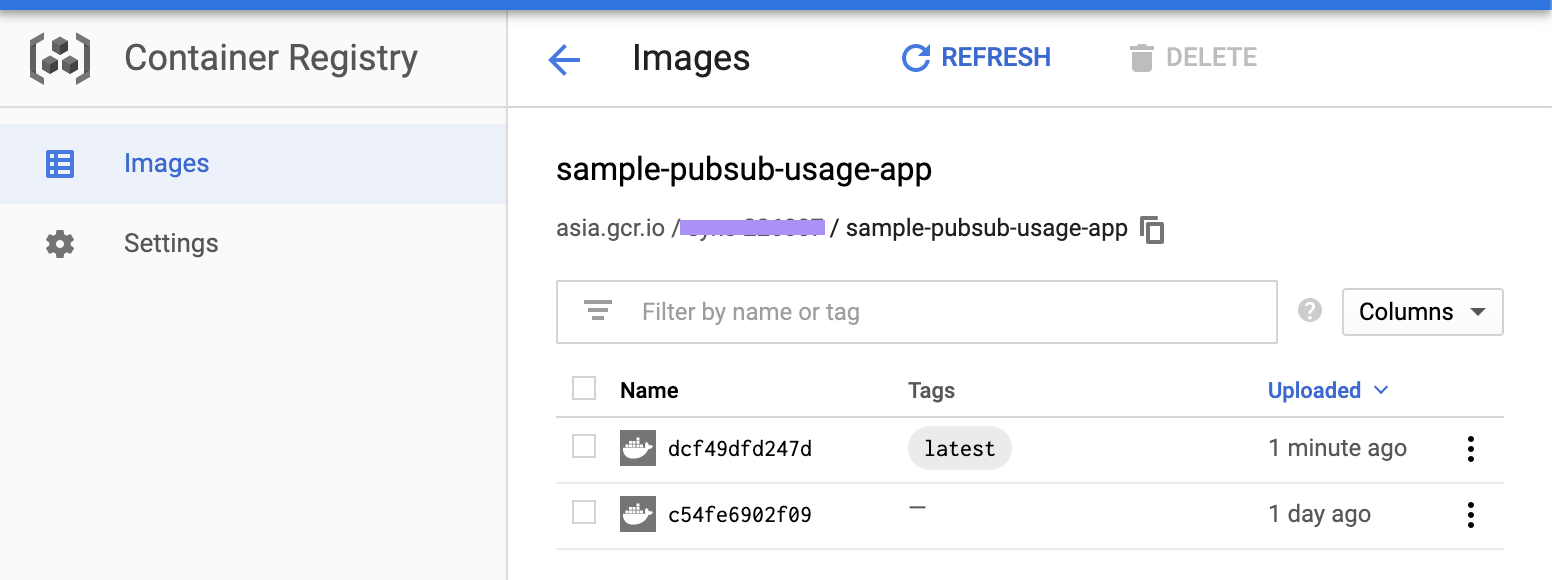

gcloud builds submit --config cloudbuild.sampleapp.yamlビルド完了となったらContainer Registryで確認する。

Cloudbuildについてさらに確認したい場合、この記事にご参考(CloudbuildでDockerイメージビルドとContainer Registryに登録)

6. GKEのCluster準備

# クラスタ作成 gcloud container clusters create ds-gke-small-cluster \ --project ds-project \ --zone asia-northeast1-b \ --machine-type n1-standard-1 \ --num-nodes 1 \ --enable-stackdriver-kubernetes # k8sコントロールツールをインストール gcloud components install kubectl kubectl version # GKEのクラスタにアクセスするため、credentialsを設定 gcloud container clusters get-credentials --zone asia-northeast1-b ds-gke-small-cluster7. GKEにアプリケーションをデプロイ

アカウントJSONファイルを「secret generic」ボリュームとしてクラスタに登録します。

kubectl create secret generic service-account-credential \ --from-file=./secret/account.jsonデプロイ定義ファイルの準備

deployment.sampleapp.yamlapiVersion: extensions/v1beta1 kind: Deployment metadata: name: sample-pubsub-usage-app spec: replicas: 1 template: metadata: labels: app: sample-pubsub-usage-app spec: volumes: - name: service-account-credential secret: secretName: service-account-credential containers: - name: sample-pubsub-usage-app-container image: asia.gcr.io/project-abc123/sample-pubsub-usage-app:latest # environment variables for the Pod env: - name: PROJECT_ID value: "project-abc123" - name: PUBSUB_SUBSCRIPTION_NAME value: "sample-app-topic-sub" - name: GOOGLE_APPLICATION_CREDENTIALS value: /app/secret/account.json volumeMounts: - mountPath: /app/secret name: service-account-credential readOnly: true【デプロイ定義の説明】

作成できた「secret generic」ボリュームをデプロイ定義にMount設定して、account.jsonファイルパスを環境変数に渡す。

「GOOGLE_APPLICATION_CREDENTIALS」の環境変数はPub/Subにアクセスするためプログラムは使います。この設定はポイントとなります。アプリケーションをGKEにデプロイします。

kubectl apply -f deployment.sampleapp.yaml8. 稼働検証

TopicにメッセージのPublishを行います。

go run tools/publish_to_topic.go --project-id=project-abc123 --topic-id=sample-app-topic

本記事で利用したソースコードはこちら

https://github.com/itdevsamurai/gke/tree/master/accesspubsub

最後まで読んで頂き、どうも有難う御座います!

DevSamurai 橋本

- 投稿日:2019-12-18T21:39:04+09:00

エラーハンドリングについて考えてみた

はじめに

今回は、外部APIからデータを取得して表示する際のエラーハンドリングについて考えてみます。

方法1

ERROR HANDLING WITH ANGULAR`S ASYNC PIPE でも紹介されている方法です。

エラーを通知する先としてSubjectを用意してそれをビューテンプレートで表示します。Service

テスト用のモックを作成します。(実際に外部APIと通信は行いません。)

get(id: number): Observable<User> { return new Observable((subscriber) => { setTimeout(() => { if (!id) { subscriber.error('id is required'); return } subscriber.next(new User(id, "hello")) subscriber.complete(); }, 1000); }) }Component

user$: Observable<User> | null = null; error$ = new Subject<Error>(); get(id: number) { this.error$.next() this.user$ = this.userService.get(id).pipe( catchError(err => { this.error$.next(err); return throwError(err); }) ); }View

asyncでuserオブジェクトを取得できない場合は、ローディング中もしくは、エラーが発生している可能性があります。

その場合は loadingOrErrorTemp を表示して、その中で、エラーが出ている場合とローディング中の場合を、error$の値を参照して判定します。<ng-container *ngIf="user$"> <div *ngIf="user$ | async as user; else loadingOrErrorTemp">{{user | json}}</div> </ng-container> <ng-template #loadingOrErrorTemp> <div *ngIf="error$ | async as err; else loadingTemp">{{err}}</div> <ng-template #loadingTemp>loading</ng-template> </ng-template>方法2

次の方法は、Go言語のエラーハンドリングからヒントを得た方法です。

Goでは、以下のように、メソッドの戻り値として、エラーを受け取りハンドリングを行います。value, err := get(id) if err != nil { log.Println(err) return }これをAngularのエラーハンドリングに適応すると以下のようになります。

Object

userオブジェクトをラップして、エラーの値もサービスから返すようにします。

export class UserResponse { user?: User; errorMsg?: string; }Service

userResponseオブジェクトを返すサービスを作成します。

getUserResponse(id: number): Observable<UserResponse> { return new Observable((subscriber) => { setTimeout(() => { const userResponse = new UserResponse(); if (!id) { const errMsg = 'id is required'; userResponse.errorMsg = errMsg subscriber.next(userResponse); subscriber.complete(); return } userResponse.user = new User(id, "hello"); subscriber.next(userResponse); subscriber.complete(); }, 1000); }) }Component

getUserResponse(id: number) :Observable<UserResponse>{ this.userResponse$ = this.userService.getUserResponse(id); }Template

前回の方法と異なり、asyncで値を取得できていない状態はローディングの時のみとなります。

<ng-container *ngIf="userResponse$"> <div *ngIf="userResponse$ | async as userResponse; else loadingTemp"> <ng-container *ngIf="userResponse.errorMsg as err">{{err}}</ng-container> <ng-container *ngIf="userResponse.user as user">{{user?.id}}</ng-container> </div> <ng-template #loadingTemp>loading</ng-template> </ng-container>まとめ

どちらの方法が良いかは好みかと思いますが、個人的には方法2の方が直感的でコードの見通しも良いのではと思いました。

- 投稿日:2019-12-18T21:28:25+09:00

Goのミドルウェアのテスト

概要

GoでWebアプリケーションを作るにあたり、gRPCとgrpc-gatewayを利用して作っています。

ここで何か全APIに共通の処理を書きたい場合、grpc-gatewayにミドルウェアを作成し、そこで処理をしてしまうことが多いです。今回はそのミドルウェアのテストを書くやり方をまとめます。

なおミドルウェアはgrpc-gatewayやgRPCに依存しているものではなく、net/httpを使っているミドルウェアであれば同様にテストが書けるはずです。業務のロジックが含まれていて割愛している所も多く、また同様の事をしている例も多々あるかと思いますが、

実際に使われているものに近いミドルウェアとそのテストとして、何かしら参考になれば幸いです。テストするミドルウェア

以下はアプリバージョンを渡してもらい、最低アプリバージョン以下だとエラーを返すというミドルウェアです。

実際のアプリケーションでは強制アップデートをかけるために利用しています。appVersion.gopackage gateway import ( "fmt" "net/http" "strconv" "github.com/andfactory/xxx-webapp/domain/model" "github.com/andfactory/xxx-webapp/domain/errors/code" "github.com/andfactory/xxx-webapp/domain/errors" "github.com/andfactory/xxx-webapp/library/env" ) const ( slackTitleAppVersionInvalid = "appVersion-invalid" headerKeyAppVersion = "App-Version" ) var minimumAppVersionIos int var minimumAppVersionAndroid int func init() { minimumAppVersionIos = env.GetMinimumAppVersionIos() minimumAppVersionAndroid = env.GetMinimumAppVersionAndroid() } // getAppVersionHeader クライアントのアプリバージョンチェックを実施するミドルウェアを取得する func getAppVersionHeader(h http.Handler) http.Handler { return http.HandlerFunc(func(w http.ResponseWriter, r *http.Request) { //不要なログ出力を避けるため、healthCheckとドキュメントルートではこのチェックをおこなわない if r.RequestURI == "/health_check" || r.RequestURI == "/" { h.ServeHTTP(w, r) return } deviceTypeStr := r.Header.Get(headerKeyDeviceType) deviceType, err := model.ConvertStringToDeviceType(deviceTypeStr) if err != nil { err := errors.WrapApplicationError(err, code.InvalidDevice, fmt.Sprintf("invalid device type: '%v'", deviceTypeStr)) setUnencryptedErrorResponse(w, slackTitleAppVersionInvalid, http.StatusBadRequest, err) return } appVersionStr := r.Header.Get(headerKeyAppVersion) appVersion, err := strconv.Atoi(appVersionStr) if err != nil { err := errors.WrapApplicationError(err, code.InvalidAppVersion, fmt.Sprintf("invalid application version: '%v'", appVersionStr)) setUnencryptedErrorResponse(w, slackTitleAppVersionInvalid, http.StatusBadRequest, err) return } var minimumAppVersion int switch deviceType { case model.DeviceTypeIOS: minimumAppVersion = minimumAppVersionIos case model.DeviceTypeAndroid: minimumAppVersion = minimumAppVersionAndroid } if appVersion < minimumAppVersion { err := errors.NewApplicationError(code.NeedUpdateApplication, fmt.Sprintf("%s Application version too low. got %d want %d", deviceType, appVersion, minimumAppVersion)) setUnencryptedErrorResponse(w, slackTitleAppVersionInvalid, http.StatusBadRequest, err) return } h.ServeHTTP(w, r) }) }テストコード

上記のミドルウェアに対しては、以下のようにテストを書くことができます。

appVersion_test.gopackage gateway_test import ( "bytes" "encoding/json" "io/ioutil" "net/http" "net/http/httptest" "testing" "github.com/andfactory/xxx-webapp/adapter/grpc/presenter" "github.com/andfactory/xxx-webapp/domain/errors/code" "github.com/andfactory/xxx-webapp/infra/grpc/gateway" ) //TestAppVersionSkip 特定のpassで処理をスキップする部分のテスト func TestAppVersionSkip(t *testing.T) { ts := httptest.NewServer(gateway.GetAppVersionHeader(GetTestHandler())) defer ts.Close() tests := []struct { name string pass string isError bool expectedCode code.ErrorCode }{ { name: "ルート", pass: "/", isError: false, }, { name: "ヘルスチェック", pass: "/health_check", isError: false, }, { name: "通常", pass: "/test", isError: true, }, } for _, tt := range tests { t.Run(tt.name, func(t *testing.T) { var u bytes.Buffer u.WriteString(string(ts.URL)) u.WriteString(tt.pass) req, _ := http.NewRequest("GET", u.String(), nil) req.Header.Set(gateway.GetHeaderKeyDeviceType(), "invalidDeviceType") req.Header.Set(gateway.GetHeaderKeyAppVersion(), "0") res, err := gateway.Client.Do(req) if err != nil { t.Fatalf("request faiulure %v", err) } if res != nil { defer res.Body.Close() } if tt.isError { var d presenter.ErrorResponse if err := json.NewDecoder(res.Body).Decode(&d); err != nil { t.Fatalf("request faiulure %v", err) } if d.Body.ErrorCode != code.InvalidDevice { t.Fatalf("return want to be %v but returned %v", tt.expectedCode, d.Body.ErrorCode) } } else { b, err := ioutil.ReadAll(res.Body) if err != nil { t.Fatalf("request faiulure %v", err) } if string(b) != "OK" { t.Fatalf("return want to be OK but returned %v", string(b)) } } }) } } //TestAppVersion appVersionでチェックする処理全般のテスト func TestAppVersion(t *testing.T) { ts := httptest.NewServer(gateway.GetAppVersionHeader(GetTestHandler())) defer ts.Close() var u bytes.Buffer u.WriteString(string(ts.URL)) u.WriteString("/test") gateway.SetMinimumAppVersionIos(50) gateway.SetMinimumAppVersionAndroid(150) tests := []struct { name string deviceType string appVersion string isError bool expectedCode code.ErrorCode }{ { name: "不正なデバイス", deviceType: "", appVersion: "50", isError: true, expectedCode: code.InvalidDevice, }, { name: "不正なデバイス", deviceType: "iOS", appVersion: "50", isError: true, expectedCode: code.InvalidDevice, }, { name: "不正なデバイス", deviceType: "3", appVersion: "50", isError: true, expectedCode: code.InvalidDevice, }, { name: "iOS不正なバージョン", deviceType: "1", appVersion: "", isError: true, expectedCode: code.InvalidAppVersion, }, { name: "iOS不正なバージョン", deviceType: "1", appVersion: "1.1.1", isError: true, expectedCode: code.InvalidAppVersion, }, { name: "iOS強制アップデート", deviceType: "1", appVersion: "49", isError: true, expectedCode: code.NeedUpdateApplication, }, { name: "iOSミニマム", deviceType: "1", appVersion: "50", isError: false, }, { name: "iOSミニマムより大きい", deviceType: "1", appVersion: "51", isError: false, }, { name: "android不正なバージョン", deviceType: "2", appVersion: "", isError: true, expectedCode: code.InvalidAppVersion, }, { name: "android不正なバージョン", deviceType: "2", appVersion: "1.1.1", isError: true, expectedCode: code.InvalidAppVersion, }, { name: "android強制アップデート", deviceType: "2", appVersion: "149", isError: true, expectedCode: code.NeedUpdateApplication, }, { name: "androidミニマム", deviceType: "2", appVersion: "150", isError: false, }, { name: "androidミニマムより大きい", deviceType: "2", appVersion: "151", isError: false, }, } for _, tt := range tests { t.Run(tt.name, func(t *testing.T) { req, _ := http.NewRequest("GET", u.String(), nil) req.Header.Set(gateway.GetHeaderKeyDeviceType(), tt.deviceType) req.Header.Set(gateway.GetHeaderKeyAppVersion(), tt.appVersion) res, err := gateway.Client.Do(req) if err != nil { t.Fatalf("request faiulure %v", err) } if res != nil { defer res.Body.Close() } if tt.isError { var d presenter.ErrorResponse if err := json.NewDecoder(res.Body).Decode(&d); err != nil { t.Fatalf("request faiulure %v", err) } if d.Body.ErrorCode != tt.expectedCode { t.Fatalf("return want to be %v but returned %v", tt.expectedCode, d.Body.ErrorCode) } } else { b, err := ioutil.ReadAll(res.Body) if err != nil { t.Fatalf("request faiulure %v", err.Error()) } if string(b) != "OK" { t.Fatalf("return want to be OK but returned %v", string(b)) } } }) } } func GetTestHandler() http.HandlerFunc { fn := func(rw http.ResponseWriter, req *http.Request) { rw.Write([]byte("OK")) return } return http.HandlerFunc(fn) }privateな情報にテストからアクセスできるようにexport_test.goを作成します。

export_test.gopackage gateway import ( "net/http" ) var Client = new(http.Client) var GetAppVersionHeader = getAppVersionHeader func SetApplicationAppVersionIos(i int) { applicationAppVersionIos = i } func SetApplicationAppVersionAndroid(i int) { applicationAppVersionAndroid = i } func GetHeaderKeyDeviceType() string { return headerKeyDeviceType } func GetHeaderKeyAppVersion() string { return headerKeyAppVersion }解説

ミドルウェアのテストをするには、テストしたいミドルウェアのみを実行するサーバを作れば実現できます。

以下のようにエラーがなかった時用のハンドラを用意し、

func GetTestHandler() http.HandlerFunc { fn := func(rw http.ResponseWriter, req *http.Request) { rw.Write([]byte("OK")) return } return http.HandlerFunc(fn) }テストしたミドルウェアを通してサーバを立ててあげます。

ts := httptest.NewServer(gateway.GetAppVersionHeader(GetTestHandler())) defer ts.Close()urlの設定は以下のようにすれば実現できます

var u bytes.Buffer u.WriteString(string(ts.URL)) u.WriteString(tt.pass) req, _ := http.NewRequest("GET", u.String(), nil)gRPCとgrpc-getewayを使うときは共通のパラメータを送るときはhttpHeaderに設定し、gRPC飲めたデータとして処理しています。headerへの設定は以下のようにします。

req.Header.Set(gateway.GetHeaderKeyDeviceType(), tt.deviceType) req.Header.Set(gateway.GetHeaderKeyAppVersion(), tt.appVersion)これで、APIにアクセスします。なおクライアントはexport_test.goで作成して使いまわしています。appVersion_test.goで作っても良いのですが、他のミドルウェアのテストでも活用したいのでこのようになってます。

res, err := gateway.Client.Do(req) if err != nil { t.Fatalf("request faiulure %v", err) } if res != nil { defer res.Body.Close() }あとはレスポンスの内容をチェックしてあげればOKです。

エラーの場合は特定の型のレスポンスを返すようにしてあるので、それをパースしてコードが意図したものになっていればOK。エラーでない場合はOKが返ってくれば正常です。if tt.isError { var d presenter.ErrorResponse if err := json.NewDecoder(res.Body).Decode(&d); err != nil { t.Fatalf("request faiulure %v", err) } if d.Body.ErrorCode != tt.expectedCode { t.Fatalf("return want to be %v but returned %v", tt.expectedCode, d.Body.ErrorCode) } } else { b, err := ioutil.ReadAll(res.Body) if err != nil { t.Fatalf("request faiulure %v", err.Error()) } if string(b) != "OK" { t.Fatalf("return want to be OK but returned %v", string(b)) } }参考

export_test.goを作って非公開の変数や関数を扱うやり方は以下で詳しく解説されてます。

非公開(unexported)な機能を使ったテスト以下の記事でも同様の事が書かれています。

Unit Testing Golang HTTP Middleware

- 投稿日:2019-12-18T19:48:30+09:00

Go言語でつくるインタプリタをやってみた

tl;dr

ただの『Go言語でつくるインタプリタ』紹介記事です。

動機

私はいつも自分の開発や日々の細かい作業をツールとしてより効率化をすることを考えています。

その結果としていくつかのCLIコマンドやVimプラグインを書いたりしているわけなのですが。

その中で今まで知らないことを盛り込むことで都度新しい知識を仕入れることを心がけています。最近Language Server Protocol(LSP)周りにご執心なのですが、

ふと自分でLanguage Server(LS)をつくりたいなと思ったのですが、そのための知識が足りないことに気が付きました。

そうLSをつくる上で対象となる言語の解析への理解は欠かせないのです。そこで私は一回インタプリタを作ったら一通りの流れを理解できるのでは?

と考えて以前から気になっていた『Go言語でつくるインタプリタ』を注文したのです。似たような話でDQNEOさんのGoコンパイラをゼロから作った話がありますが、

このような壮大は話に比べるといささか小規模ではありますね。『Go言語でつくるインタプリタ』のよいところ

結論から述べましょう。『Go言語でつくるインタプリタ』は本当に素晴らしい本です。

著者であるThorsten Ball氏。そしてこの素晴らしい内容を余すことなく日本語で伝えてくれた設樂 洋爾氏には本当に感謝の気持ちでいっぱいです。言語を自分でつくるというのは、プログラマであれば一度はやってみたいことではないでしょうか?

しかしその反面どのように作ればよいのか、いまいちイメージ出来ないものでもあります。

やってみようと調べるとすると以下のようないかにも難しい本が出てきて、ぐぬぬとなること請け合いなわけです。私もいつかは読んでみたいなと思いつつも二の足を踏み続けていましたし、

やっぱり言語をつくるなんて一部の人間のみに許された神の諸行なのではと思ってしまっていたわけです。『Go言語でつくるインタプリタ』のよいところはその難しい要素をうまく噛み砕き、

躓きそうな要素を慎重に配置して、一つ一つ確実につなげてゆき、読者に確かな達成感を与えることに成功しています。

それらの要素を軽快な語り口で次はどうなるんだと常に楽しみにさせるところも注目です。適切な流れ

『Go言語でつくるインタプリタ』の基本的な流れは、

インタプリタの主要要素である以下の3つを順番に構築していくようになっています。

- 字句解析器(Lexer)

- 構文解析器(Parser)

- 評価器(Evaluator)

字句解析器でソースコードをトークン列に変換し、

構文解析器でトークン列をAST(抽象構文木)に変換し、

最後に評価器でプログラムに意味を与えます。それぞれのフェーズで完全にデータ型などをすべて作り込むことはせずに、まずはインタプリタとして通して動作するところまでを作成するのが秀逸です。

一旦インタプリタとして完全に動作する段階に行くと君はすごい偉業を成し遂げたと褒めちぎってくれます。

その後に文字列や配列, ハッシュマップなどを追加実装していくのですが。一連の流れはすでに抑えているので、だいたいどこを触るべきなのかが予測できるようになるはずです。幾多に張り巡らされた伏線(コード)が徐々に解き明かされる様は、さながら出来の良いミステリを見ているような感覚です。

テストコード

この手の写経(ソースコードを教科書から書き写す行為)は、ソースの間違えによるバグに引っかかって、結局バグが解消出来ずに途中で止まってしまうのが一番の難関ではないかと思います。

特にこの本は200ページ以上に渡り、一つのプロジェクトを触り続けていくわけで、その間に一つでもミスがあればインタプリタは期待した動きにはなりません。その問題に対応するために、この本はTDD(テスト駆動開発)を採用し、関数の仕様を全て記載した上で、実装に移るスタイルをとっています。

それらのテストコードは長大な説明文章よりも、はるかに雄弁にソースの振る舞いを語ります。なるほどこういうケースに対応するために実装がこうなっているのだなと納得しながら実装することが出来ます。最悪テストコードを記載することが面倒であれば、公開されているテストコードをペタペタ貼ってゆけばよいのです。

テストコードの内容自体もところどころで検証をするためのヘルパー関数を作って、冗長性なく快適にテストコードを書けるようにするような工夫が随所に見られます。

SubTestの未対応バージョンのGoをベースに作っているので、最新の形式でかけるわけではないですが。それでもどういうテストをするべきなのかを知るという点においても非常に勉強になります。Go標準ライブラリのみ

このおかげでGoのみインストールすれば始められます。

またコード中に出てくるものはほとんど基本的な記述のみになるので、内容も非常に簡素になるわけです。最後に

もしプログラミング言語を作ることに少しでも興味でもあれば是非一度見てほしい一冊です。

- 投稿日:2019-12-18T17:47:11+09:00

Go Lang Hello world 超簡単言語(GOlang)

ちっとお試しあれ

<<みんなでGO>>

main.gopackage main import ( "net/http" "fmt" ) func world(w http.ResponseWriter, r *http.Request) { fmt.Fprintf(w, "<a href='/japan'><h1>Hello World</h1></a>") } func japan(w http.ResponseWriter, r *http.Request) { fmt.Fprintf(w, "<a href='/'><h1>Hello Japan</h1></a>") } func main() { http.HandleFunc("/", world) http.HandleFunc("/japan", japan) http.ListenAndServe("192.168.1.10:8080", nil) }

- 投稿日:2019-12-18T16:10:13+09:00

Goで一通りのsql操作をやってみる

この記事はtomowarkar ひとりAdvent Calendar 2019の18日目の記事です。

はじめに

Goでのmysql操作を備忘録としてまとめてみた

コード全文

コード全文

package main import ( "database/sql" "fmt" "log" _ "github.com/go-sql-driver/mysql" ) const appname = "gopherbot" func run() (*sql.DB, error) { dbDriver := "mysql" dbUser := "root" dbPass := "password" dbName := "" db, err := sql.Open(dbDriver, dbUser+":"+dbPass+"@/"+dbName) if err != nil { return nil, err } defer db.Close() res, _ := db.Query("SHOW DATABASES") var database string for res.Next() { res.Scan(&database) fmt.Println(database) } fmt.Println() _, err = db.Exec("CREATE DATABASE IF NOT EXISTS " + appname) if err != nil { return nil, err } res, _ = db.Query("SHOW DATABASES") for res.Next() { res.Scan(&database) fmt.Println(database) } fmt.Println() _, err = db.Exec("USE " + appname) if err != nil { return nil, err } res, _ = db.Query("SHOW TABLES") var table string for res.Next() { res.Scan(&table) fmt.Println(table) } fmt.Println() _, err = db.Exec("CREATE TABLE IF NOT EXISTS example ( id integer, name varchar(32) )") if err != nil { return nil, err } ins, err := db.Prepare("INSERT INTO example(id,name) VALUES(?,?)") if err != nil { return nil, err } ins.Exec(1, "hoge") ins.Exec(3, "huga") res, _ = db.Query("SELECT * FROM example") for res.Next() { var id int var name string res.Scan(&id, &name) fmt.Println(id, name) } fmt.Println() _, err = db.Exec("DROP DATABASE " + appname) if err != nil { return nil, err } return db, nil } func main() { _, err := run() if err != nil { log.Fatal(err) } }outputmysql gopherbot mysql 1 hoge 3 hugaデータベース接続, 切断

dbDriver := "mysql" dbUser := "root" dbPass := "password" dbName := "" db, err := sql.Open(dbDriver, dbUser+":"+dbPass+"@/"+dbName) if err != nil { log.Fatal(err) } defer db.Close()データベース表示(SHOW DATABASES)

res, _ := db.Query("SHOW DATABASES") var database string for res.Next() { res.Scan(&database) fmt.Println(database) }データベース作成(CREATE DATABASE)

_, err = db.Exec("CREATE DATABASE IF NOT EXISTS " + yourDatabsase) if err != nil { log.Fatal(err) }データベース選択(USE)

_, err = db.Exec("USE " + yourDatabsase) if err != nil { log.Fatal(err) }テーブル表示(SHOW TABLES)

res, _ = db.Query("SHOW TABLES") var table string for res.Next() { res.Scan(&table) fmt.Println(table) }テーブル作成(CREATE TABLE)

_, err = db.Exec("CREATE TABLE IF NOT EXISTS " + yourTable + " ( id integer, name varchar(32) )") if err != nil { log.Fatal(err) }データ挿入(INSERT)

ins, err := db.Prepare("INSERT INTO " + yourTable + "(id,name) VALUES(?,?)") if err != nil { log.Fatal(err) } ins.Exec(1, "hoge") ins.Exec(3, "huga")データ表示(SELECT)

res, _ = db.Query("SELECT * FROM " + yourTable) for res.Next() { var id int var name string res.Scan(&id, &name) fmt.Println(id, name) }データベース削除(DROP DATABASE)

_, err = db.Exec("DROP DATABASE " + yourDatabsase) if err != nil { log.Fatal(err) }おわりに

以上明日も頑張ります!!

tomowarkar ひとりAdvent Calendar Advent Calendar 2019参考

https://qiita.com/merrill/items/967884c02e10bd8f32f5

https://medium.com/@udayakumarvdm/create-mysql-database-using-golang-b28c08e54660

https://flaviocopes.com/golang-sql-database/

- 投稿日:2019-12-18T15:58:17+09:00

Gobotを使ってトイレ混雑問題と真剣に向き合ってみた

この記事はGo3 Advent Calendar 2019の19日目です。

はじめに

人類はこれまで幾度となく文明を進化させてきましたが、今だに解決仕切れていない問題があります。

そう、それは「トイレ混雑問題」。人間として生きていくためには避けて通れない問題です。最近ではこの問題を危惧した様々な企業さん達が、こぞって記事を出しています。

『駅の空いてるトイレが分かる』アプリケーションを開発。「これを待っていた!」とSNSで話題に

弊社もオフィスによっては個室の数が少なく、空いているかいないかのチェックに苦労している人もいるそうです。

その為、この問題をIoTで簡単に解決できないかと考え、「ラズパイ×Gobot」でトイレの混雑検知の仕組みを試作してみました!!!

構成

この辺りの記事を参考に構成を組んでいます。

【Raspberry Pi】自作人感センサーの使い方と活用法

ソースコード

人感センサで人を感知した後に、人の背後に置いた超音波センサで人が席を離れたどうかを判定します。

超音波センサの判定距離はデモ用に作っているので、適当に設定しています。

slackへの通知はincoming-webhookを使い、このために作った専用のチャンネルに送信しています。import ( "gobot.io/x/gobot/drivers/gpio" "gobot.io/x/gobot/platforms/raspi" "time" "encoding/json" "fmt" "io/ioutil" "net/http" "net/url" "gobot.io/x/gobot" ) const ( SensorValueDetect = 1 SensorValueUndetect = 0 ) func main() { err := motion() if err != nil { println(err) } } func motion() error { r := raspi.NewAdaptor() f := false trigPin := gpio.NewDirectPinDriver(r, "11") echoPin := gpio.NewDirectPinDriver(r, "13") work := func() { gobot.Every(3*time.Second, func() { // 7番ピンから直接センサーの値を読み取る v, _ := r.DigitalRead("7") if v == SensorValueDetect { if f == false { slack.SlackPostIn("誰かが来た様です。") f = true } println("Starting probing ") err := trigPin.DigitalWrite(byte(0)) if err != nil { println(err) return } time.Sleep(2 * time.Microsecond) err = trigPin.DigitalWrite(byte(1)) if err != nil { println(err) return } start := time.Now() end := time.Now() for { val, err := echoPin.DigitalRead() start = time.Now() if err != nil { println(err) break } if val == 0 { continue } break } for { val, err := echoPin.DigitalRead() end = time.Now() if err != nil { break } if val == 1 { continue } break } duration := end.Sub(start) distance := duration.Seconds() * 34300 distance = distance / 2 println(distance) if distance > 1000 { println(distance) slackPostOut("部屋が空きました。") f = false } } }) } robot := gobot.NewRobot("blinkBot", []gobot.Connection{r}, []gobot.Device{trigPin, echoPin}, work, ) robot.Start() return nil } var IncomingURL string = "incoming-webhookで取得したURL" // jsonの情報 type Slack struct { Text string `json:"text"` Username string `json:"username"` IconEmoji string `json:"icon_emoji"` IconURL string `json:"icon_url"` Channel string `json:"channel"` } func slackPostIn(text string) { arg := text params := Slack{ Text: fmt.Sprintf("%s", arg), Username: "Close Push", IconEmoji: ":cold_sweat:", IconURL: "", Channel: "", } jsonparams, _ := json.Marshal(params) resp, _ := http.PostForm( IncomingURL, url.Values{"payload": {string(jsonparams)}}, ) body, _ := ioutil.ReadAll(resp.Body) defer resp.Body.Close() println(string(body)) } func SlackPostOut(text string) { arg := text params := Slack{ Text: fmt.Sprintf("%s", arg), Username: "Open Push", IconEmoji: ":relaxed:", IconURL: "", Channel: "", } jsonparams, _ := json.Marshal(params) resp, _ := http.PostForm( IncomingURL, url.Values{"payload": {string(jsonparams)}}, ) body, _ := ioutil.ReadAll(resp.Body) defer resp.Body.Close() println(string(body)) }結果

...なんか

鬱陶しいメンヘラチックですね。さいごに

これ実は弊社の開発合宿で作った成果物でした!下記はその時の内容が書かれているテックブログです。

【チェックリスト付き】開発合宿 運営マニュアル 〜計画から実施までの流れ〜かなり短い時間で開発を行ったのですが、Gobotでの実装がかなり楽ですぐ作ることができました。シビアな実行環境でなければ、組み込みの軽いプロトタイプを作る際におすすめです!

本記事で紹介したソースコードは

とても汚い試作要素が強いので、実行環境によってステータスとかいじって使ってみてください!トイレにはハードルが高い...という方は普通にGobotの一例として参考にしていただければと思います。

- 投稿日:2019-12-18T10:39:08+09:00

Datadogでハマった3つのこと

これは何か

Kyash Advent Calender 2019 の20日目の記事です。

Kyashには2019/5/20にサーバサイドエンジニアとして入社し、本日12/20でちょうど7か月となります。普段はWalletチーム(Kyashアプリを開発しているチーム)のサーバサイドを担当しています。

すでに導入してあるDatadogとNewRelicをDatadog一本にすることになり、その際の移行のついでにちゃんとやれてない部分や新しいマイクロサービスへの導入を行った時に想定外に大ハマりしたのでその共有を3つに絞ってしたいと思います。

テーマからして万人ウケするタイプではないですが、世の中にDatadog関連の情報が少ないこともあり、これから導入しようとしている人に参考になればと思います。

そもそもDatadogとはを簡単に

Datadogとは何?

というのを簡単に説明しとこうと思います。

一言で表現するのは難しいのですが、「サーバ、アプリケーション等システム全体の状態をモニタリングするプラットフォーム」と言えると思います。

- サービスをまたがってアプリケーションのパフォーマンスを分析するAPM(トレース)

- サーバーから送られてくるCPU使用率などのほか、ユーザが自由に送ることもできるMetrics

- それらのDashboard

- メトリクスなどからメール、SNSなどに通知するMonitor

- ログを収集するLog Collector

等があり、かつそれらがお互いに協調してます。例えばAPMを使うと自動的にそのspanに応じたメトリクスが作成され、そのメトリクスをダッシュボードにして視覚化しつつ、メトリクスの値を元に閾値をMonitorに登録しSNSに通知できるようにするといった具合です。さらに、ちょっとした工夫(traceID等を出力する)をするだけでAPMの画面上でtraceに紐づくログが確認できたりもします。

特に、Kyashでは10以上のマイクロサービスが動いており、高負荷時の調査などの場合にどのマイクロサービスのどの処理が遅延していて、そのときのホストの状態はどうだったのかがAPMで見ると大変わかりやすく視覚化でき、感動しました。やっぱりグラフが綺麗ですよね!

参考までに以下は実際のAPMのトレースの一つをスクリーンショットです。

それぞれの区間(spanという)は親子関係を持つことができ、なおかつサービスをまたがって保持することができます。ではハマったことを次章から紹介していきます

Traceできなくてハマった

元々検証できる環境がなかったため、ローカルのdocker環境で検証できる様にしたのですが、全くtraceが表示されず、これだけで半日つぶしました。

原因はわかってしまえば単純なのですが、APMではデフォルトだとサンプリングされ、全てtraceされるわけではなかったのでした。本番環境等ではリクエストが多いので気づきませんでしたが、検証するときには必ずtraceできるようにして欲しいですよね。

サンプリングの挙動はこちらのドキュメントにもちゃんと説明されてますが、目立たないところにあり気づかなかった方もいるのでは。

簡単にまとめると

- リクエスト数、エラー数、レイテンシなどの統計値はサンプリングに関係なく、保持される

client->trace agent->Datadog server-> と3箇所でサンプリングされる- デフォルトだとサンプリングされるが、100%保持 or 削除するように設定可能

- サンプリングされたものは6時間は閲覧可能だが、次の日には25%、1週間後には10%しか残らない

のようです。

今回は、ローカル環境でのみ

span.SetTag(ext.ManualKeep, true)により必ずtraceするようにすることで解決しました。また、確証はないですが、自分の観測範囲では以下でした。

- デフォルトのサンプリングでは1割ほどしかtraceされない

span.SetTag(ext.ManualKeep, true)によりspanの子孫のコントロールはできるが、先祖についてはコントロールできないリクエストにクエリがひもづかなくてハマった

元々クエリ単体のtraceはできていたのですが、それにリクエストが紐づいておらず、一連の処理の中でどのSQLにどのくらい時間がかかっているかわからない状態でした。

Walletチーム(Kyashアプリを開発しているチーム)ではORMライブラリにGORMを利用しているのですが、GORMのtraceのドキュメントにある例を参考にしてもよくわかりません。

困っていて調べていたところ、現在は他社で活躍している入社時のメンターの記事をたまたま発見し、こちらを参考に以下のように解決することができました。記事ではリクエストにクエリが紐づき、それとは別にクエリのみが紐づく問題の対処方法でしたが、そもそもクエリをリクエストに紐づける場合には

gormtrace.WithContextを呼ぶ必要があります。GORM以外のライブラリもだいたい同じようなライブラリを呼ぶことになると思います。

// 一度だけ呼びます func newConnection() (db *gorm.DB) { // WithCallbacks registers callbacks to the gorm.DB for tracing. // It should be called once, after opening the db. // The callbacks are triggered by Create, Update, Delete, // Query and RowQuery operations. db, _ := gorm.Open("postgres", connStr) db = gormtrace.WithCallbacks(db) return db } // リクエストのコンテキストを引数に渡し、dbと紐付けます func DBWithContext(ctx context.Context) *gorm.DB { db := database.Connection() // WithContext attaches the specified context to the given db. The context will // be used as a basis for creating new spans. An example use case is providing // a context which contains a span to be used as a parent. return gormtrace.WithContext(ctx, db) }メモリリークしまくってハマった

ローカルで動作確認できたし、次はstaging環境で確認するだけだ!

とおもったら最後にまたハマりました。一つめはメモリ使用量のグラフです。(ホスト二つを別に表示してます) 笑ってしまうくらい綺麗に増加してますね。。

あるタイミングで急激に減ってるのはOOM Killerが走っているためです。二つ目のグラフはGoルーチンの数のグラフです。今回ランタイムメトリクスを有効にしたのでせっかくだし載せてみました。

この二つから明らかにGoルーチンが回収されずにメモリがリークしているのがわかります。

複数のライブラリのバージョンを最新にしたり、色々な設定変更を行ったりを同時にしているため、何が原因なのかすぐにはわからず、しばらく単調増加/減少しているグラフを見ると拒否感を覚える日々が続きました。

が、様々な状況証拠からメトリクスを送ることができるライブラリ

https://github.com/DataDog/datadog-go

が怪しそうだと思ったので、ソースをじっくり読むことにしましたが、2000行もないくらいの量でしたので数時間でリークしている箇所を発見しました。よし、PR送るぞ! と意気込んだ矢先、三日前に他の人がPRを送っており、先にソース読む前にPRを確認しろよと若干自分に苛立ちましたが、ライブラリの設計は参考になりそうなところも多く勉強になったのでいいことにします。

また、ソースを読んでみて気づいたのですが、アーキテクチャからしてリクエストのたびに

openするような設計ではなく、openしてからcloseされるまで最低4MBのメモリと3つのGoルーチンが消費されることに気づきました。なので、この機会にアプリ起動時のみ

openするようにしました。

ちなみにそれであれば今回のバグは踏まないはずです。自分が確認する限りはアーキテクチャが一新され、パフォーマンスが劇的によくなった

https://github.com/DataDog/datadog-go/pull/91

の変更で混入したバグだったのでバグが発見され修正されるまで1か月半ほどかかったことになります。スター数180なのでそこまでメジャーとは言えないライブラリなのでそういう場合は最新ではなくちょっと古いバージョンを選んだほうがいいのかなとか思ったりしましたが、難しいですね。。最新のbugfixを入れ込みたいですし。

最後に参考までに、どのようなバグだったのか極限まで簡潔にしたものを以下に載せておきます。

極限まで簡潔に書くとこんな感じのソース

type Client struct { stop chan struct{} // 処理不要であることを通知するためのチャネル } func (c *Client) watch() { ticker := time.NewTicker(c.flushTime) for { select { case <-ticker.C: // dosomething(4MB以上のメモリを辿れる) case <-c.stop: ticker.Stop() return } } } func (c *Client) watch2() { ticker := time.NewTicker(c.flushTime) for { select { case <-ticker.C: // dosomething(4MB以上のメモリを辿れる) case <-c.stop: ticker.Stop() return } } } //アプリケーションからcloseされるときに呼ばれる func (c *Client) Close() error { select { case c.stop <- struct{}{}: default: } }c:=client {} c.stop=make(chan struct{}, 1) go c.watch() go c.watch2()アプリケーションがcloseしても、goルーチンが一つ生き残ったままなので、確保したメモリがgcされておりません。

この簡単なケースでは、case c.stop <- struct{}{}:のところをclose(c.stop)にすればいいはずです。最後に

今回datadogをいい感じにしようとしたところ、知識ゼロの状態から取り組んだため、想定外に時間がかかってしまいましたが、Kyash Advent Calender 2019 4日目の記事にある「日頃の開発ではできないことを行うクォーター中に1週間の期間」でこの課題に取り組むことができたため、腰をすえて取り組むことができました。通常のプロジェクトと並行してでは難しかったでしょう。

なお、プロジェクトでは、先日発表された新しいカードに初期から関わっており、このあたりの話を来年春あたりにKyash Meetupなどで話せたらなと思っているので興味ある人は是非!!

- 投稿日:2019-12-18T10:28:03+09:00

クローリングのベンチマーク取ってみました。

はじめに

agouti を使ってクローリングを行い、ベンチマークを測定してみました。

クローリング対象ページ

今回クローリング対象のページは、goのtemplateパッケージを使用してローカルに生成したものを利用しました。以下では9つのページを生成しています。

func createPages() { createPage("/1", []string{"/2", "/3"}) createPage("/2", []string{"/4", "/5"}) createPage("/3", []string{"/6", "/7"}) createPage("/4", []string{"/8", "/9"}) createPage("/5", nil) createPage("/6", nil) createPage("/7", nil) createPage("/8", nil) createPage("/9", nil) http.ListenAndServe(":8080", nil) } func createPage(url string, links []string) { handler := newHandler(links) http.HandleFunc(url, handler) } func newHandler(links []string) func(w http.ResponseWriter, r *http.Request) { return func(w http.ResponseWriter, r *http.Request) { temp := "template.html.tmpl" t := template.Must(template.New(temp).ParseFiles(temp)) if err := t.Execute(w, links); err != nil { log.Fatal(err) } } }template.html.tmpl

<!DOCTYPE html> <html> <body> <div> {{range .}} <p><a href="{{.}}">{{.}}</a></p> {{end}} </div> </body> </html>クローラー

再起的にクローリングを行いページ内のリンクを取得するクローラーを作成しました。

// maxConcurrent = クローリング最大平行数 // maxCrawlCount = クローリングするページの最大数 func Crawls(link string, maxConcurrent int, maxCrawlCount int) ([]string, error) { errCh := make(chan error) go func() { worklinks <- link }() for i := 0; i < maxConcurrent; i++ { go func() { for link := range unseen { links, err := crawl(link) if err != nil { errCh <- err return } for _, l := range links { l := l go func() { worklinks <- l }() } } }() } for link := range worklinks { if !seen[link] { seen[link] = true unseen <- link } if len(seen) >= maxCrawlCount { links := make([]string, 0, len(seen)) for k := range seen { links = append(links, k) } return links, nil } } return nil, nil } // ページ内のリンクを検索 func crawl(link string) ([]string, error) { driver := agouti.ChromeDriver( agouti.ChromeOptions("args", []string{ "--headless", }), ) if err := driver.Start(); err != nil { return nil, errors.Wrap(err, "Failed to start driver") } defer driver.Stop() p, err := driver.NewPage() if err != nil { return nil, err } err = p.Navigate(link) if err != nil { return nil, err } t := p.All("a") length, err := t.Count() if err != nil { return nil, err } links := []string{} for i := 0; i < length; i++ { link, err := t.At(i).Attribute("href") if err != nil { return nil, err } links = append(links, link) } return links, nil }Benchmark測定

最大平行数を変えてベンチマークを測定してみました。現在の実装だと平行数を単純に増やせばその分早くなるというわけではないことがわかりました。。今後改善していきたいと思います。

平行数 処理時間(ns) 1 16479309835 2 10561147824 3 8914031897 4 8981436252 5 7767930345 10 6496013517 50 8146189396 func BenchmarkCrawl1(b *testing.B) { benchmark(b, 1) } func BenchmarkCrawl2(b *testing.B) { benchmark(b, 2) } func BenchmarkCrawl3(b *testing.B) { benchmark(b, 3) } func BenchmarkCrawl4(b *testing.B) { benchmark(b, 4) } func BenchmarkCrawl5(b *testing.B) { benchmark(b, 5) } func BenchmarkCrawl10(b *testing.B) { benchmark(b, 10) } func BenchmarkCrawl10(b *testing.B) { benchmark(b, 50) } func benchmark(b *testing.B, maxConcurrent int) { go func() { createPages() }() for i := 0; i < b.N; i++ { links, err := Crawls("http://localhost:8080/1", maxConcurrent, 9) b.Logf("links: %v", links) if err != nil { b.Error(err) return } } }

- 投稿日:2019-12-18T10:28:03+09:00

クローリングのベンチマークを取ってみました。

はじめに

agouti を使ってクローリングを行い、ベンチマークを測定してみました。

クローリング対象ページ

今回クローリング対象のページは、goのtemplateパッケージを使用してローカルに生成したものを利用しました。以下では9つのページを生成しています。

func createPages() { createPage("/1", []string{"/2", "/3"}) createPage("/2", []string{"/4", "/5"}) createPage("/3", []string{"/6", "/7"}) createPage("/4", []string{"/8", "/9"}) createPage("/5", nil) createPage("/6", nil) createPage("/7", nil) createPage("/8", nil) createPage("/9", nil) http.ListenAndServe(":8080", nil) } func createPage(url string, links []string) { handler := newHandler(links) http.HandleFunc(url, handler) } func newHandler(links []string) func(w http.ResponseWriter, r *http.Request) { return func(w http.ResponseWriter, r *http.Request) { temp := "template.html.tmpl" t := template.Must(template.New(temp).ParseFiles(temp)) if err := t.Execute(w, links); err != nil { log.Fatal(err) } } }template.html.tmpl

<!DOCTYPE html> <html> <body> <div> {{range .}} <p><a href="{{.}}">{{.}}</a></p> {{end}} </div> </body> </html>クローラー

再帰的にクローリングを行いページ内のリンクを取得するクローラーを作成しました。