- 投稿日:2020-10-12T23:49:55+09:00

【Python】スプラトゥーン2のリーグマッチデータを相関係数表を使って分析する

【Python】スプラトゥーン2のリーグマッチデータを相関係数表を使って分析する

はじめに

スプラトゥーン2の戦績データは任天堂のサーバーに直近50試合分が保管され、公式アプリ「イカリング2」で確認することが出来る。後述する「ikaWidget2」では、この戦績データをダウンロード・保存し、キルやデスの平均値や、ステージ毎の勝率等の統計データが取得できる。「スプラデータクラブ」等のWebサイトでは、「ikaWidget2」に保存されたデータを用いることで、より詳細な統計データを得ることが出来る。しかし、こういった統計データの多くは各個人の戦績に基づいたものであり、4人用モード「リーグマッチ」における自チーム内の相互作用に着目した解析ツールはほとんどない。本記事では「リーグマッチ」における自チーム内スコアの相関係数表を計算するライブラリを作成し、それを利用して試合の分析を行う。

スプラトゥーン2とは

概要

スプラトゥーン2は任天堂より2017年7月21日に発売されたアクションシューティングゲームである。2020年10月現在1000万本以上が販売されている。発売から3年以上が経過した今でも定期的にアップデートがされる大人気ゲームである。仕様

プレイヤーはイカ(orタコ)に扮したキャラクターとなり、水鉄砲やローラー等の武器でインクを塗りあって戦う。インクを敵に浴びせれば倒すこともできる(キル)。倒されたプレイヤーは約10秒程度で復活する。どのルールも4対4のチーム戦であるため、チーム内の連携が重要になる。ステージを自チームのインクで塗るとスペシャルポイントが溜まり、強力な「スペシャルウェポン」が使えるようになる。ただし、敵に倒されるとスペシャルポイントが半分になってしまう。

ルール

ナワバリバトル

制限時間内に相手より広く地面を塗ったチームが勝利となる。スプラトゥーンにおける基本ルール。

ガチエリア

ステージ内に配置された「ガチエリア」を自陣のインクで占拠した時間を競う。ナワバリバトルを局所化して、占拠時間による勝敗を設けたゲーム。

ガチヤグラ

「ガチヤグラ」に乗り込み、制限時間内に相手チームのゴールまで近づけたチームが勝利となる。上に乗ることで「ガチヤグラ」を進めることが出来るが、敵からは格好の的になってしまう。

ガチホコバトル

「ガチホコ」と呼ばれる巨大な水鉄砲を拾い、制限時間内に相手チームのゴールまで近づけたチームが勝利となる。「ガチホコ」を持ったプレイヤーは強力な「ガチホコショット」を放つことが出来るようになるが、敵チームから位置がバレてしまい、狙われやすくなる。

ガチアサリ

ステージに散らばった「アサリ」を拾い、相手チームのゴールに入れて得点を競う。ゴールは初め、バリアで守られているため、アサリを10個集めて「ガチアサリ」を作りバリアを破壊しなければならない。バリアを破壊すると一定時間相手チームのゴールにアサリを入れられるようになる。

リーグマッチ

フレンドと4人チームを作って他のチームと対戦するモード。リーグマッチでは、「ガチエリア」「ガチヤグラ」「ガチホコバトル」「ガチアサリ」の4つの対戦ルールで遊ぶことが出来る。

相関係数表とは

相関係数

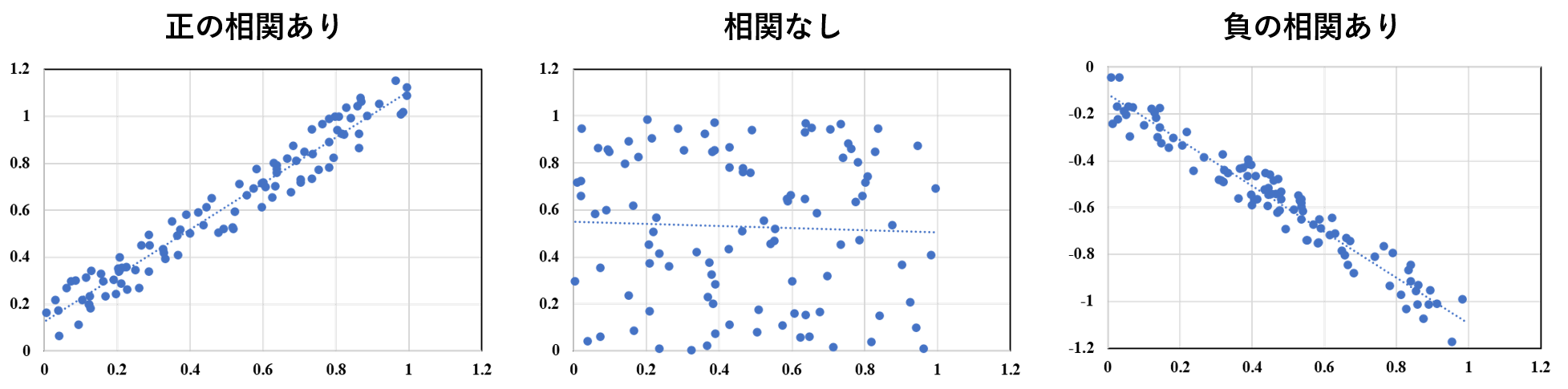

相関係数とは、2つの変数間の関係の強さを表す-1から+1の指標である。相関係数が正の時は「正の相関」が、負の時は「負の相関」があるという。正の相関がある時、2つの変数はいわゆる「正比例」のような関係になり、一方が増加する時もう一方も増加する。負の相関がある時は正の相関とは逆に、一方が増加する時もう一方は減少する。例えば、身長と体重の関係は強い正の相関を示し、国の失業率と経済成長率は負の相関を示す。

相関係数の絶対値とその相関の強さの関係は以下である。

相関係数 abs(r) 相関の強さ 0.7 ≦ abs(r) 強い相関がある 0.4 ≦ abs(r) ≦ 0.7 相関がある 0.2 ≦ abs(r) ≦ 0.4 弱い相関がある 0 ≦ abs(r) ≦ 0.2 ほとんど相関がない 相関係数表

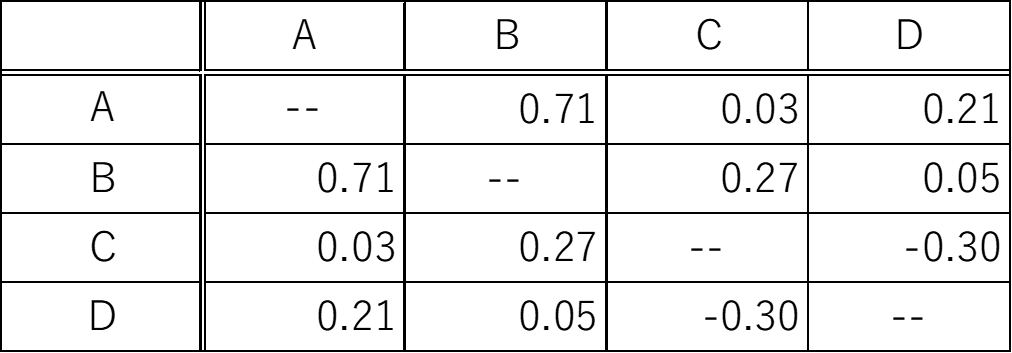

相関係数表は、各2変数間の相関係数をまとめた表である。

上図は、変数A,B,C,Dの相関係数表である。相関係数表はその特性上、表の左下と右上の値が線対象になる。ある2変数の行と列が交わった位置の値がその2変数の相関係数になる。例えば、変数BとCの相関係数は0.27になる。

このように、取り扱う変数が多い場合には相関係数表を用いることで、各変数間の関係をわかりやすく記述することが出来る。ikaWidget2

ikaWidget2は、任天堂非公式のスプラトゥーン2の分析アプリである。

App Store : https://apps.apple.com/jp/app/ikawidget-2/id1271025591

Google Play : https://play.google.com/store/apps/details?id=com.flapg.ikawidget2&hl=ja任天堂のサーバーに保管された直近50試合をダウンロード・保管し、キルやデスの平均値や、ステージごとの勝率等の統計データが取得できる。下図は、ikaWidget2の実際の画面である。

ikaWidget2はデータの外部出力機能も搭載しており、jsonとcsv(拡張子.tcsv)形式に対応している。今回は、ikaWidget2から出力されたcsvを使って相関係数表の計算を行う。環境

- Python

- pandas

- DateTime

- openpyxl

計算方法

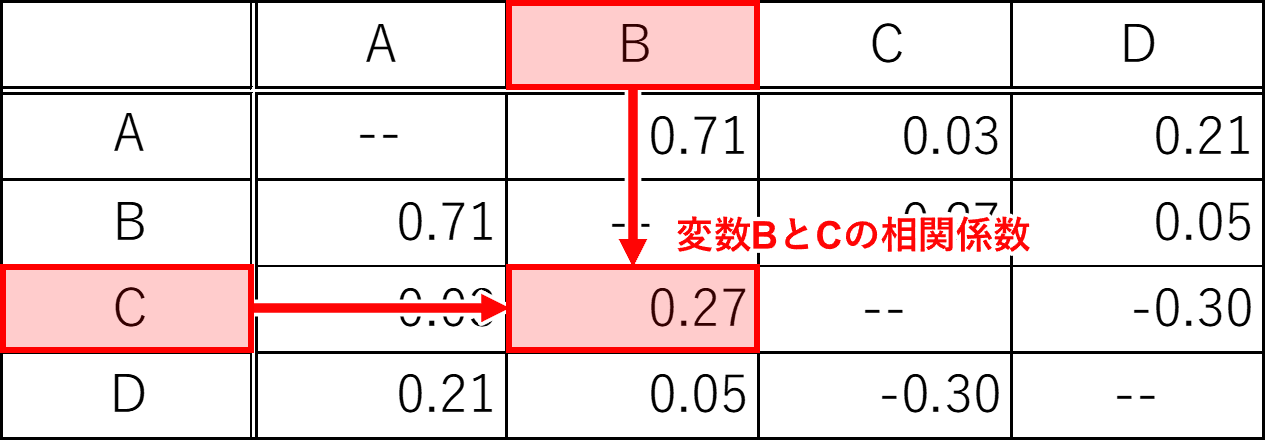

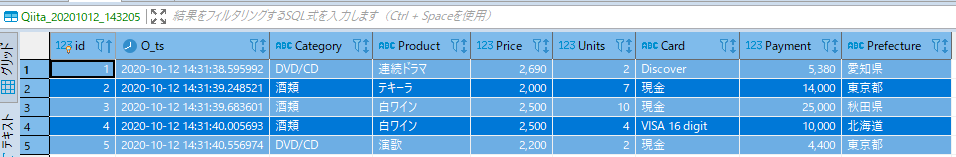

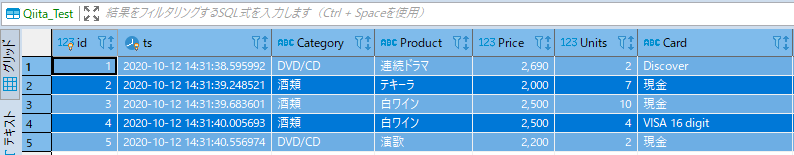

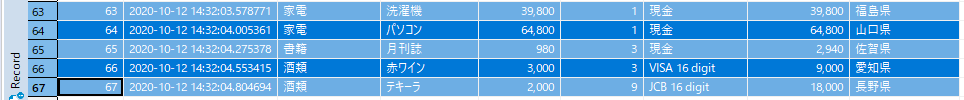

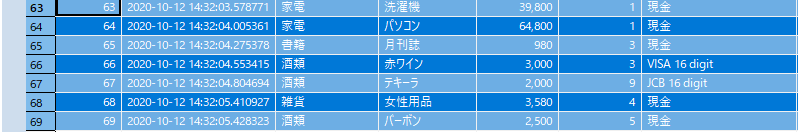

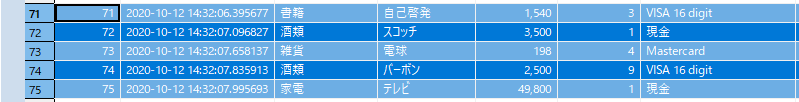

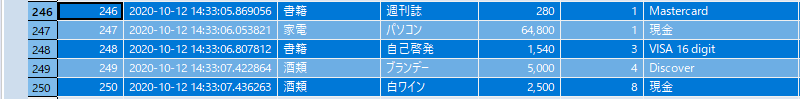

ikaWidget2のcsvファイルの構造を以下に示す。

共通データは試合の開始日時やステージ、ゲームモード等である。共通データ以降はキルやデス数等のプレイヤー情報が自分→味方→敵の順番に並ぶ。味方データの順番は試合ごとにバラバラであるため、このデータ群からリーグマッチの相関係数表を計算する際には、味方データとフレンド個々人の紐づけが必要になる。これをスプラトゥーン2のユーザーネームを用いて行うこともできるが、Nintendo Switchのユーザーネームを変更するとスプラトゥーン2のユーザーネームも変更されてしまうため普遍的でなく、汎用性に乏しい。ここでは「PrincipalID」を使って紐づけを行う。「PrincipalID」はユーザー固有の値であり、ユーザーネームを変更しても変わることはない。この値は内部データであるためゲーム中では確認出来ないが、ikaWidget2から出力されるファイルから取得できる。キルやデス数をフレンド毎に整理することが出来れば、後はpandasの.corr()関数で容易に相関係数表を作成することが出来る。ダウンロード・インストール

今回作成したスプラトゥーン2リーグマッチ相関係数表計算ライブラリ「splatoon_league_corr」はGitHub及びPyPlにアップロード済みである。

GitHub : https://github.com/JmpM-0743/splatoon_league_corr.git

PyPlからインストールする場合はpipでインストールできる。

pip install splatoon_league_corrライブラリの使い方

splatoon_league_corrでは、以下のクラス及び関数を提供する。

class ika_data

プレイヤーデータの格納クラス。

コンストラクタ

def __init__(self,pid,jpname,usname)

メンバ変数 説明 pid プレイヤーのPrincipalID

PrincipalIDは内部データなのでゲーム内では確認できないが、

ikaWidget2から出力されるtcsvファイル等から取得できるjpname 相関係数表出力時に表示される名前 usname 戦績データ一覧出力時に表示される名前 使用例

player = splatoon_league_corr.ika_data('824a58fc35365d11','まるや','maruya')class team_data

4つのika_dataで構成されるチームクラス。

コンストラクタ

def __init__(self,player,friend1,friend2,friend3)

メンバ変数 説明 player tscvファイルを出力した本人のデータ friend1~3 同じチームのフレンドデータ 使用例

myteam = splatoon_league_corr.team_data(player,friend1,friend2,friend3)calc_corr_number_of_games(filename,save_dir,myteam,n)

試合数を引数にして相関係数表のエクセルファイル(result.xlsx)を出力する関数。

引数 説明 型 filename 入力するtcsvファイルのパス str save_dir 出力データを格納するディレクトリ名(自動生成) str myteam team_dataクラス team_data n 相関係数表を計算する際の試合数 int 使用例

splatoon_league_corr.calc_corr_number_of_games('ikaWidgetCSV_20201009231053.tcsv','output',myteam,50)calc_corr_days(filename,save_dir,myteam,datemin,datemax)

試合の期間を引数にして相関係数表のエクセルファイル(result.xlsx)を出力する関数。

引数 説明 型 filename 入力するtcsvファイルのパス str save_dir 出力データを格納するディレクトリ名(自動生成) str myteam team_dataクラス team_data datemin、datemax 相関係数表を計算する際の試合期間(datemin~datemax)

YYMMDDで記述する。str 使用例

splatoon_league_corr.calc_corr_days('ikaWidgetCSV_20201009231053.tcsv','output_date',myteam,'20200901','20201030')分析結果と考察

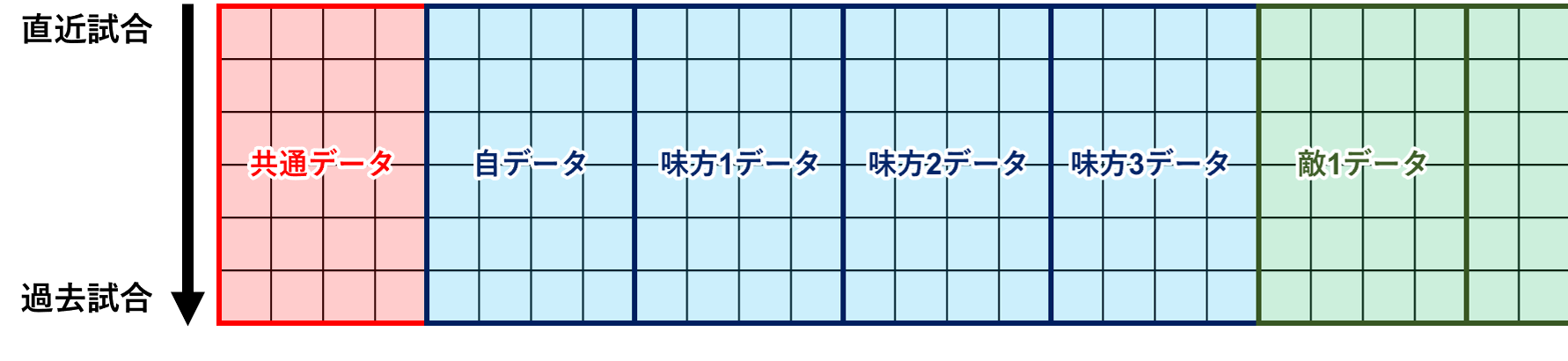

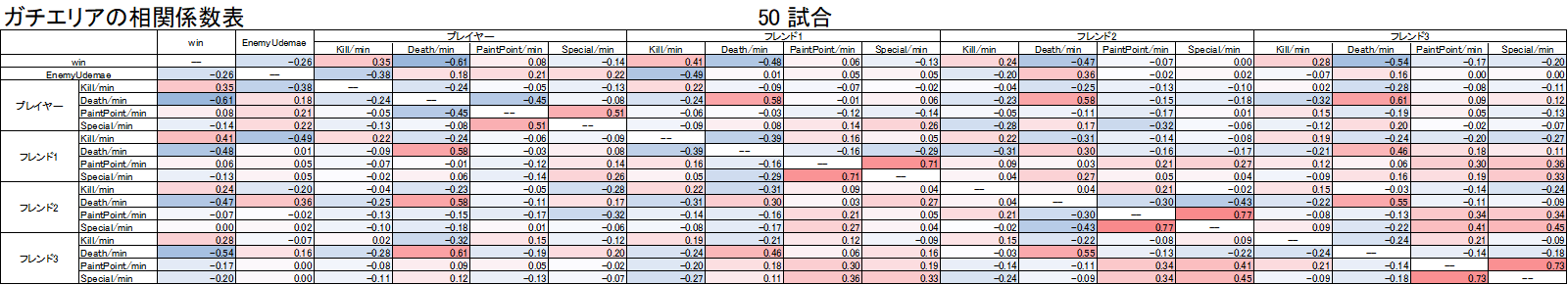

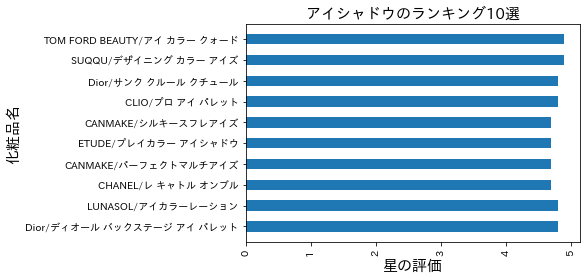

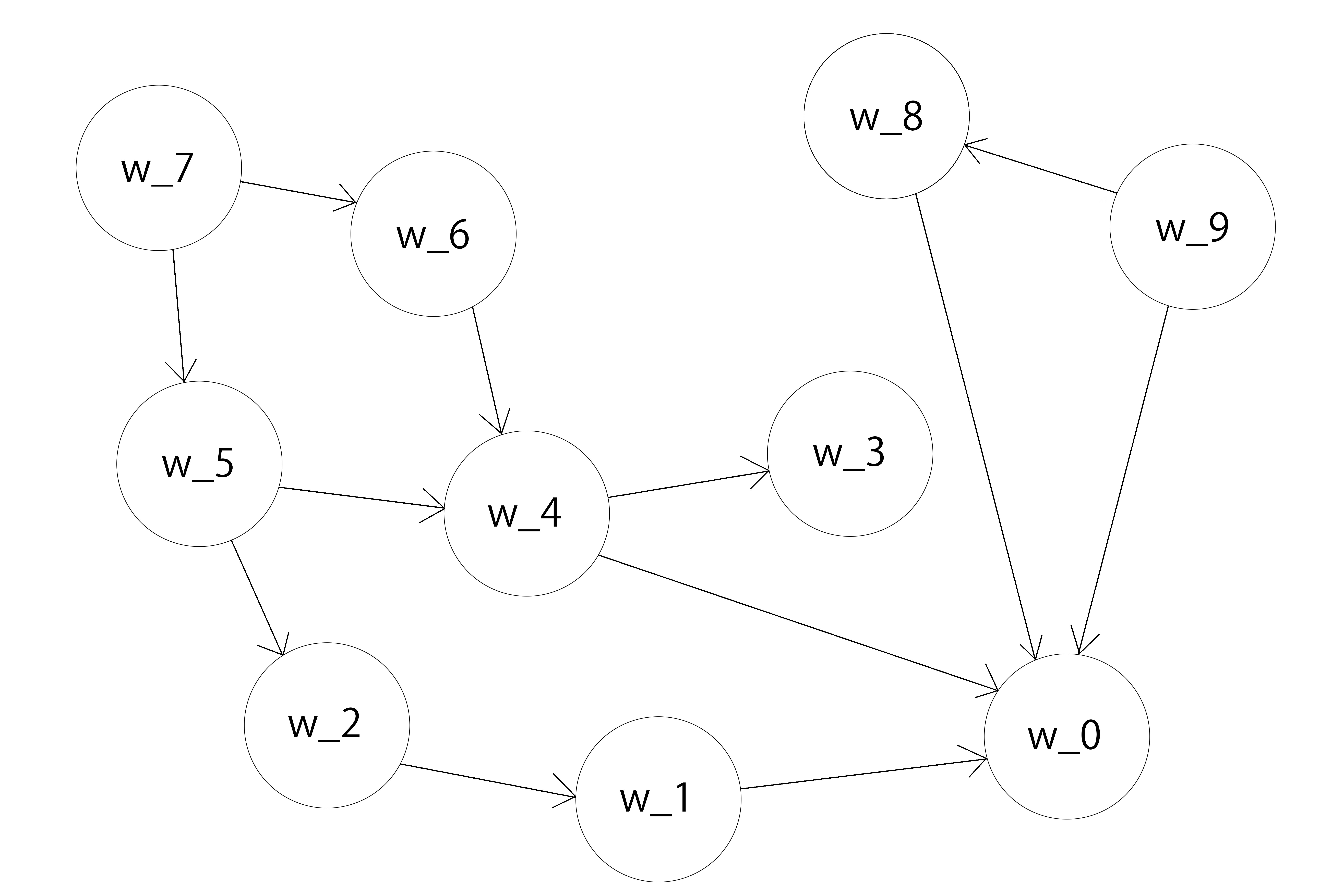

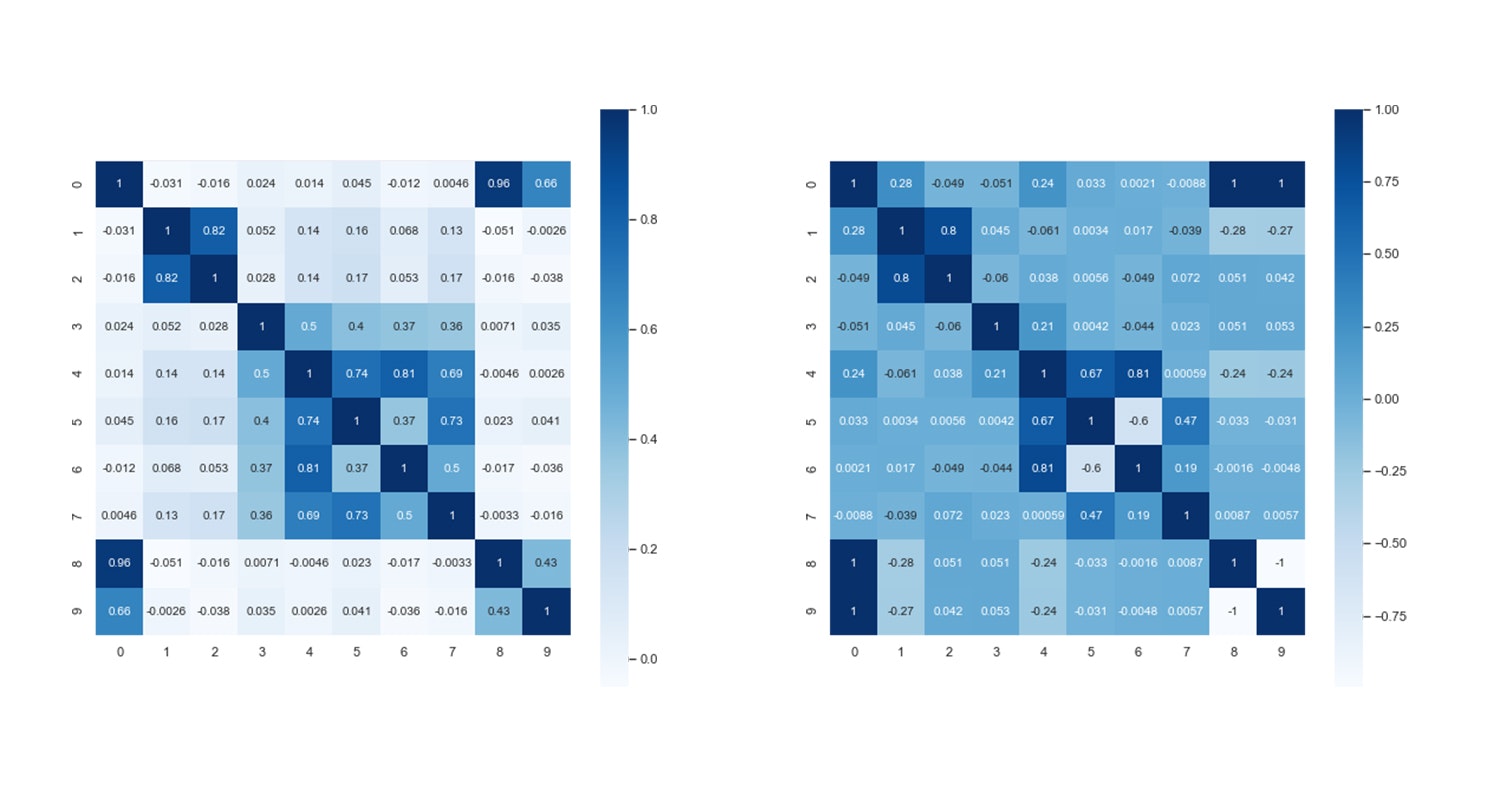

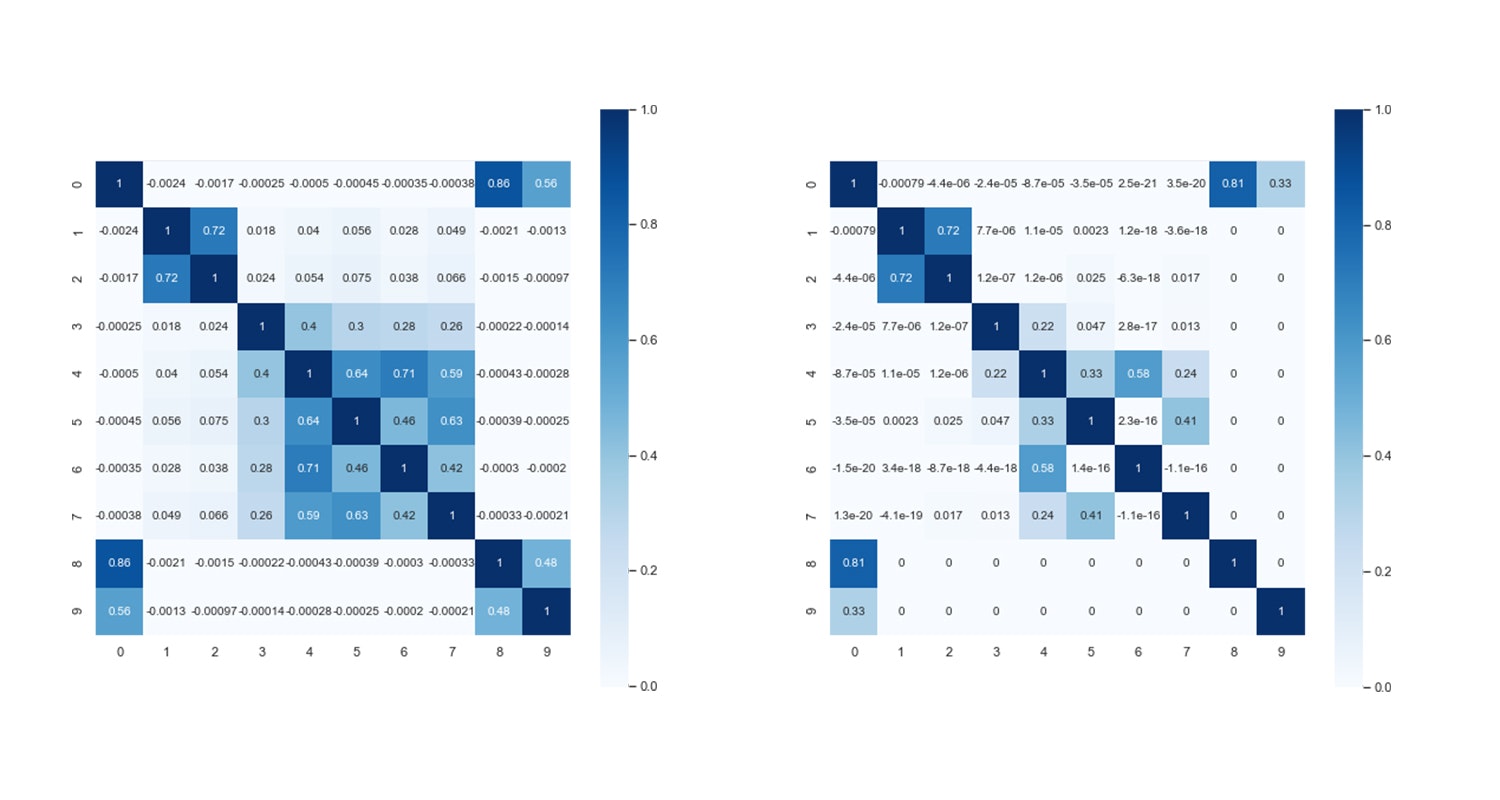

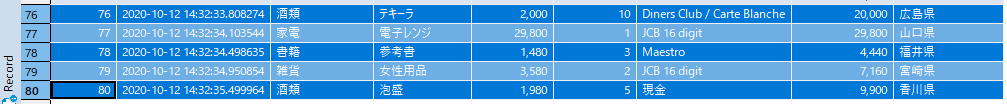

以下に、筆者のチームのガチエリア50試合分の相関係数表を示す。

この表ではノックアウトによる値のズレを防ぐため、試合中の各変数は分当たりの値としている。

変数名 説明 win 試合の勝敗 勝利が1で敗北が0 EnemyUdemae 敵チームの平均ウデマエ

ウデマエ : 一人用プレイモードにおけるランクのようなものKill/min 分当たりのキル数 Death/min 分当たりのデス数 PaintPoint/min 分当たりの塗りポイント Special/min 分当たりのスペシャルウェポン発動回数 分析の例として、この表からわかること・わかりそうなことを述べていく。

① 相関係数の大きい変数ペア

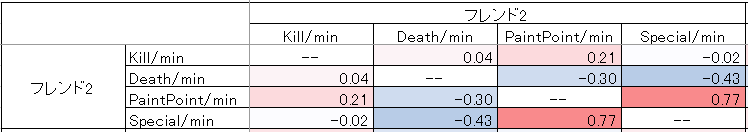

フレンド2の

PaintPoint/minとSpecial/minの相関係数が0.77と、表中で一番大きい値をとっている。これら2変数の相関係数は、プレイヤーや他のフレンドも同様に高い値をとっている。前述の通り、スペシャルウェポンは塗りポイントが一定量溜まると発動できるため、この結果は妥当といえる。

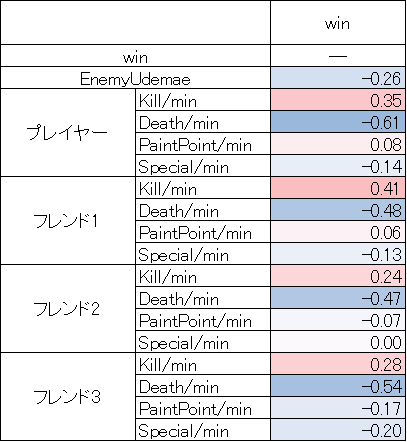

② 勝利に影響している変数

勝利との相関が最も強い変数は、フレンド1の

Kill/minであるが、他のプレイヤー・フレンドも同様に高く、突出はしていない。「キルが多いと勝ちやすい」ことは自明であるため、この結果も妥当である。逆に、負の相関が最も強いのはプレイヤーのDeath/minで、相関係数-0.61である。この値は他フレンドと比較しても大きく、プレイヤーが頻繁にデスしているときは負けやすい、と言えるだろう。③ 敵のウデマエに関する相関

敵の強さによって味方の立ち回りがどのように変わるのかを分析する。こちらは、先程までと比べて個々人の特色がよく表れている。例えば、敵のウデマエが高い時は「キルが減ってデスが増える」ことが自然な流れだが、フレンド1は敵のウデマエとデス数の相関がなく、フレンド3はキル数との相関がない。

フレンド1は後衛武器を持つことが多く、前衛の味方がやられた時に自陣に下がり易いためデスが増えないと考えられる。きちんと生存している一方で、キル数の負相関はチームで一番大きく、敵が強いと苦戦している様子も伺える。

プレイヤーは他のフレンドと比較して塗りポイントとスペシャルの相関が少し高い。敵が強いと中々倒せなくなるため、地面を塗ってスペシャルで対抗しようとしていることが見て取れる。

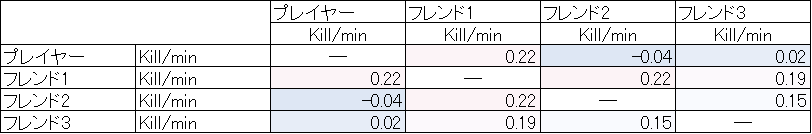

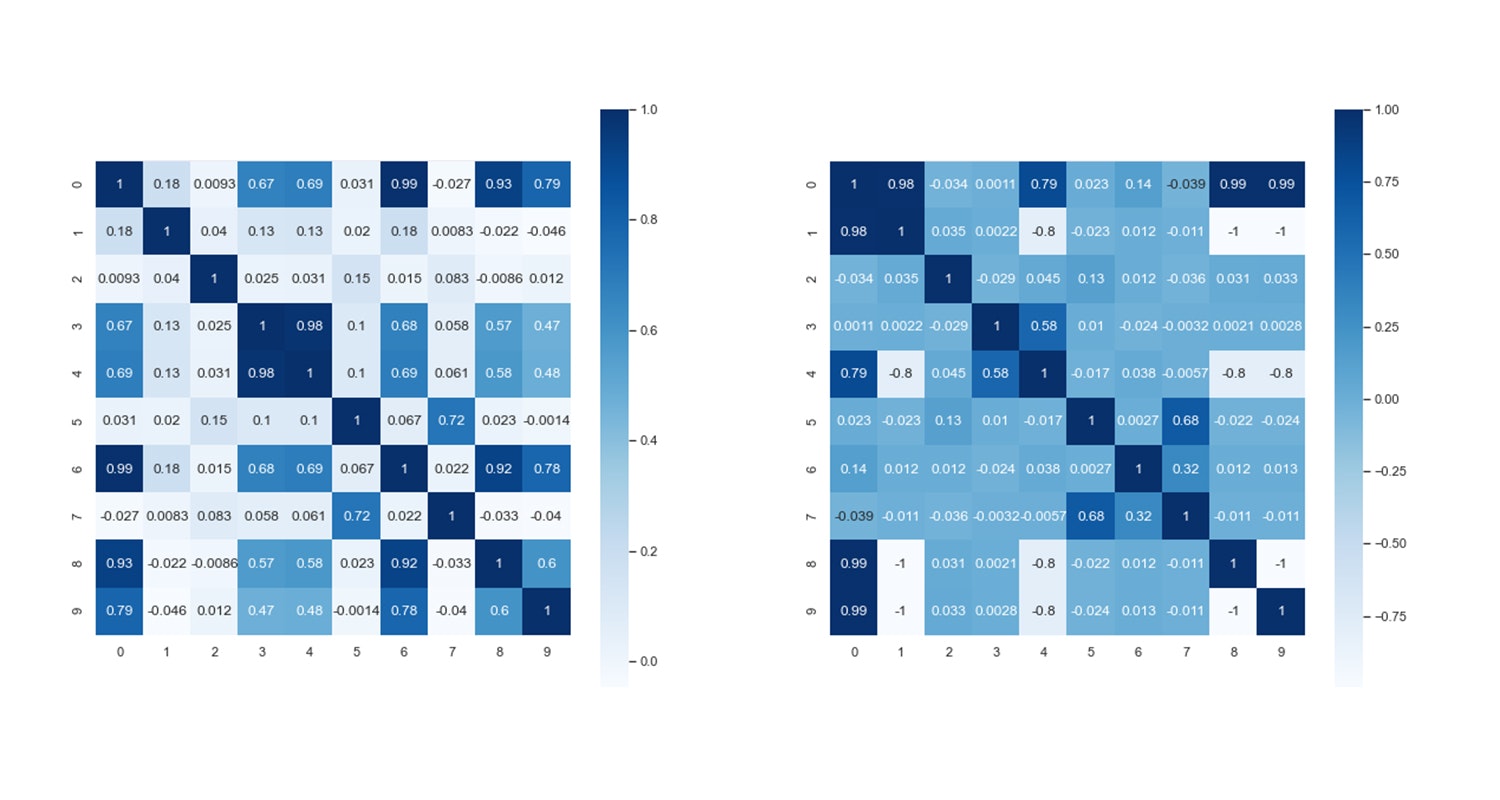

④ チーム内の相関を考える

最後に、チーム内の相関を分析してみる。下図は、キル数のみに着目した相関係数表である。この表を見ると、プレイヤーのみフレンド1以外のフレンドとのキル相関がほとんどないことが確認できる。言い換えると、プレイヤーのキルは他の前衛武器のキル数に何の影響も与えていないと言える(前述の通りフレンド1は後衛武器メイン)。明確な事はこの表からだけではわからないが、プレイヤーが前線から浮いていることや、逆に前線から手前側の位置で戦っていることを示していると考えられる。

まとめ

- ikaWidgetとPythonを用いることで、リーグマッチデータの相関係数表の計算が可能になった。

- 相関係数表の利用により、各個人のキルやデスだけではわからなかったチーム内の相互作用や、個々人のプレイ状況まで可視化できるようになった。

- 投稿日:2020-10-12T23:48:55+09:00

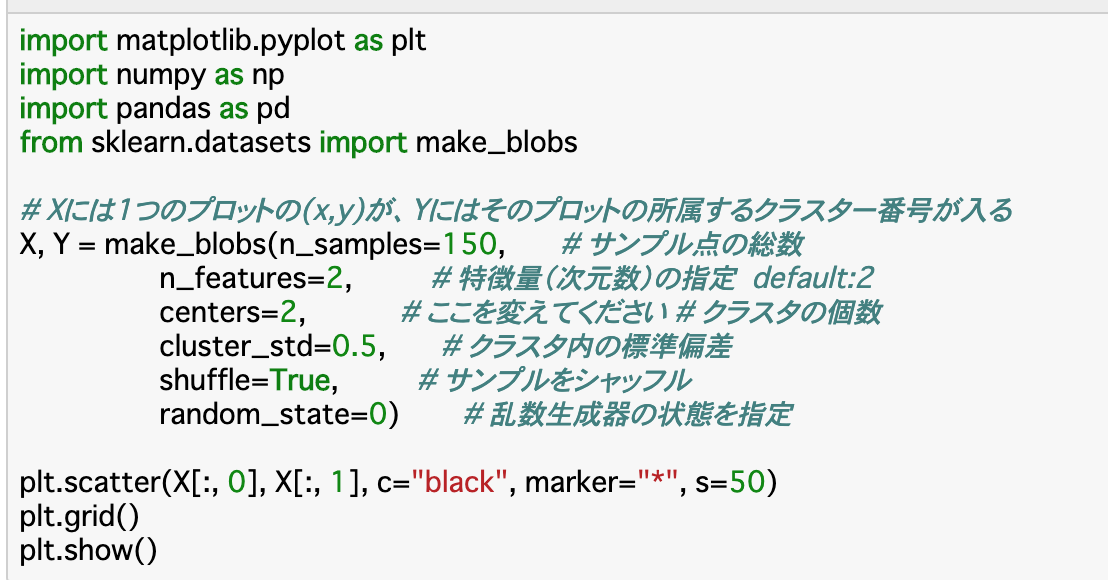

教師なし学習3 主成分分析

Aidemy 2020/10/29

はじめに

こんにちは、んがょぺです!バリバリの文系ですが、AIの可能性に興味を持ったのがきっかけで、AI特化型スクール「Aidemy」に通い、勉強しています。ここで得られた知識を皆さんと共有したいと思い、Qiitaでまとめています。以前のまとめ記事も多くの方に読んでいただけてとても嬉しいです。ありがとうございます!

今回は、教師なし学習の3つ目の投稿になります。どうぞよろしくお願いします。*本記事は「Aidemy」での学習内容を「自分の言葉で」まとめたものになります。表現の間違いや勘違いを含む可能性があります。ご了承ください。

今回学ぶこと

・主成分分析について

・カーネル主成分分析について主成分分析

主成分分析について

・主成分分析は、少ないデータから元のデータを表すこと、すなわちデータの要約(圧縮)を行う手法の一つである。

・主成分分析を行うと、「全てのデータを効率よく説明できる軸(第一主成分軸)」と「それだけでは説明しきれないデータを効率よく説明できる軸(第二主成分軸)」が作成される。

・このうち第一主成分のみを使うことで、余分なデータを捨てられ、データが圧縮できる。

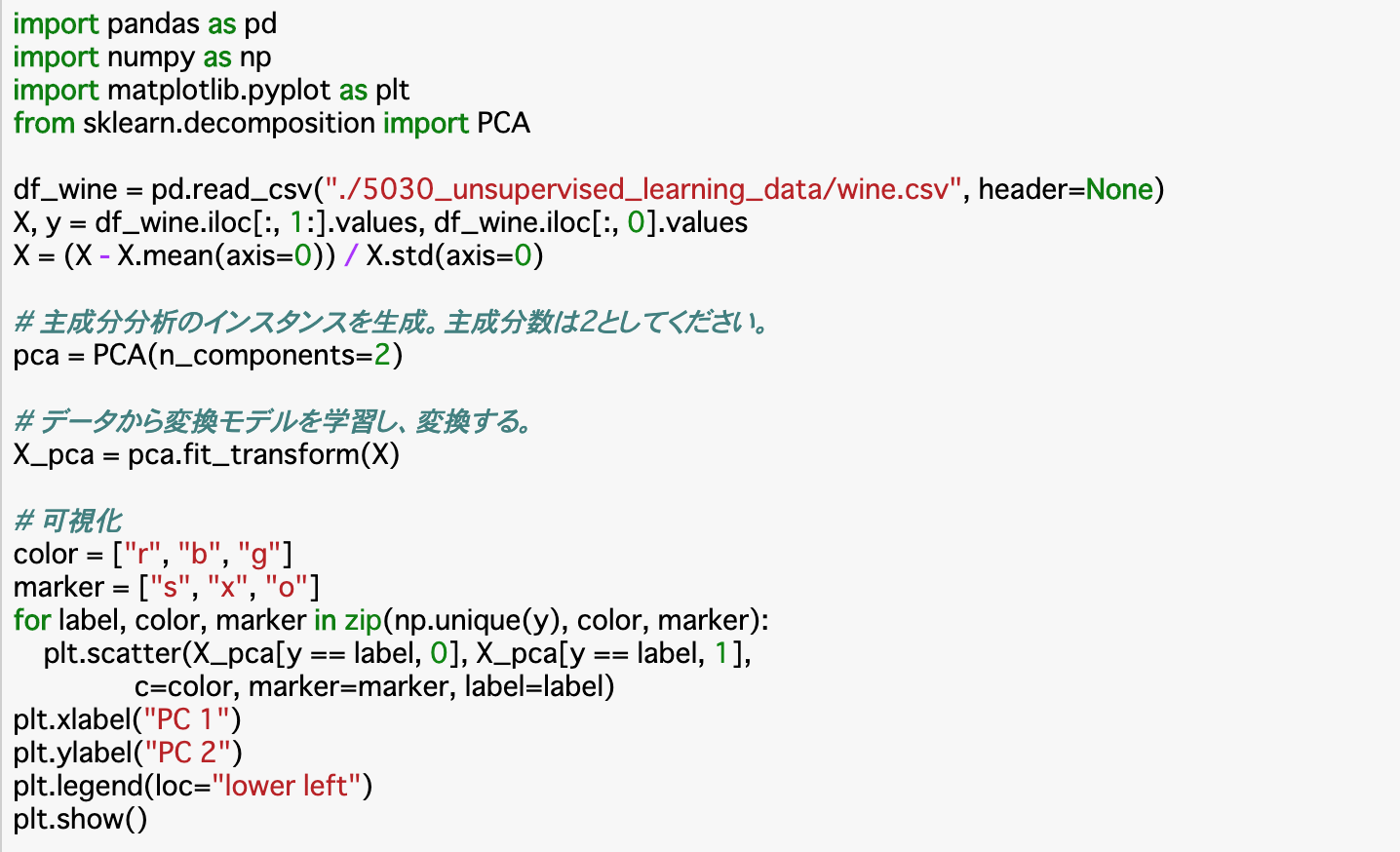

・主成分分析を使えば次元削減も行えるので、データを2、3次元に落として可視化させたり、回帰分析に使えるようにしたりできる。主成分分析の流れ(概要)

①データXを標準化する。

②特徴同士の相関行列を計算する。

③相関行列の固有値と固有ベクトルを求める。

④固有値の大きい方からk個(k=圧縮したい次元数)選び、対応する固有ベクトルを選択する。

⑤選んだk個の固有ベクトルから特徴変換行列Wを作成する。

⑥データXと行列Wの積を計算し、k次元に変換されたデータX'を得る。(終了)主成分分析① 標準化

・標準化とは、データの各特徴を、平均を0分散を1になるように変換することである。

・標準化を行うことで、単位や基準の異なるデータを同じように扱えるようになる。・標準化は以下のように行われる。 (データと平均の差)÷標準偏差

X = (X - X.mean(axis=0))/X.std(axis=0)主成分分析② 相関行列

・相関行列とは、各特徴データ同士の相関係数がk×k個集まった行列のことである。

相関係数は2データ間の直線的な関係性の強さを表し、1に近いほど「aが正の一次関数の傾向が強い」すなわち、正の相関が強いと言え、-1に近いほど「aが負の一次関数の傾向が強い」すなわち、負の相関が強いと言える。

・相関係数が0に近いときは、直線的な傾向があまりないことを示す。・相関行列Rの計算は以下のように行われる。

R = np.corrcoef(X.T)・相関行列を行うnp.corrcoef()に渡すのが、転置を行ったデータX.Tであるのは、Xのまま渡すとデータそのもの(行同士)の相関行列を計算してしまうためである。今回は「特徴データ(列同士)」の相関行列を計算したいので、このような場合は転置すれば良い。

主成分分析③ 固有値と固有ベクトル

・②で求めた相関行列Rは、固有値分解というものを行うと固有値と固有ベクトルに分解される。この二つはそれぞれ行列の次元数と同じ個数で分解される。

・固有ベクトルが示すのは、行列Rにおいてその方向に情報が集中していること、固有値はその集中の度合いを示す。・固有値分解は以下のように取得できる。変数のeigvalsに固有値が、eigvecsに固有ベクトルが昇順で格納される。

eigvals, eigvecs = np.linalg.eigh(R)主成分分析④⑤⑥ 特徴変換

・ここでは、データの次元を任意のk次元に変換する手順を見ていく。

・③で分解した固有値のうち大きいものからk個を使って変換する(④)。具体的には、このk個の固有値にそれぞれ対応する固有ベクトルを連結して特徴変換行列Wを作成する(⑤)。最後に、このWとデータXをかけることで、k次元に変換されたデータX'を取得することができる(⑥)。・変換行列Wの作成方法は以下の通りである。(2次元に変換したい場合)

W = np.c_[eigvecs[:,-1],eigvecs[:,-2]]・XとWの積は「行列積」なのでX.dot(W)で計算する。

主成分分析①〜⑥を簡単に行う

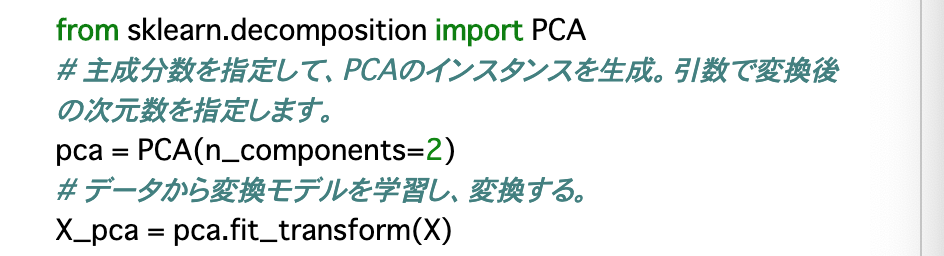

・以上①〜⑥の手順で主成分分析を行うことができるが、PCAというscikit-learnのクラスを使うことで簡単に主成分分析を行うことができる。

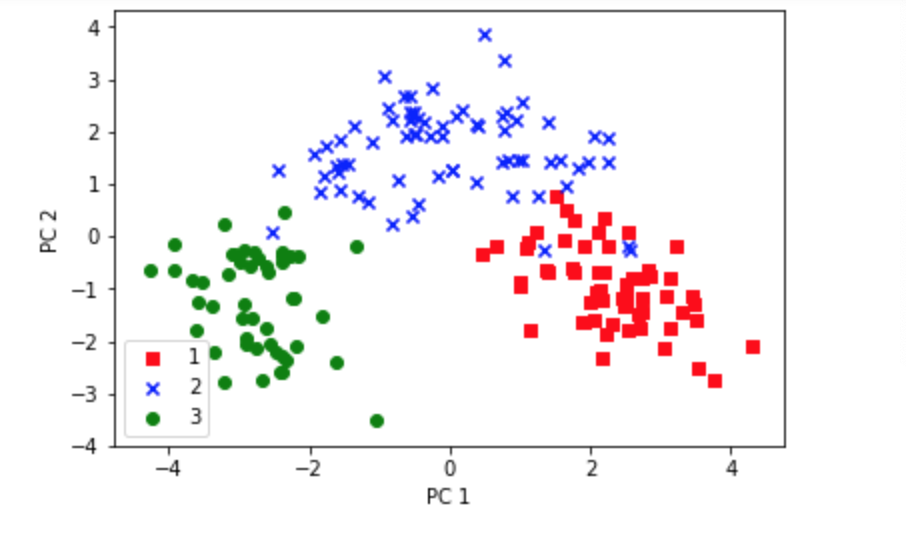

回帰分析の前処理としての主成分分析

・LogisticRegression()を使用した回帰分析を実行する前に、主成分分析を行ってデータを圧縮しておくことで、より汎用性の高いモデルを作ることができる。

・以下では、データを分割したX_trainとX_testについて、標準化と主成分分析を行う。標準化には「StandardScaler」クラス、主成分分析にはPCAクラスを使うと良い。また、トレーニングデータとテストデータは共通の基準で処理する。

・trainデータは学習させる必要があるので「fit_transform()」を使い、testデータはそのまま「transform()」を使えば良い。カーネル主成分分析

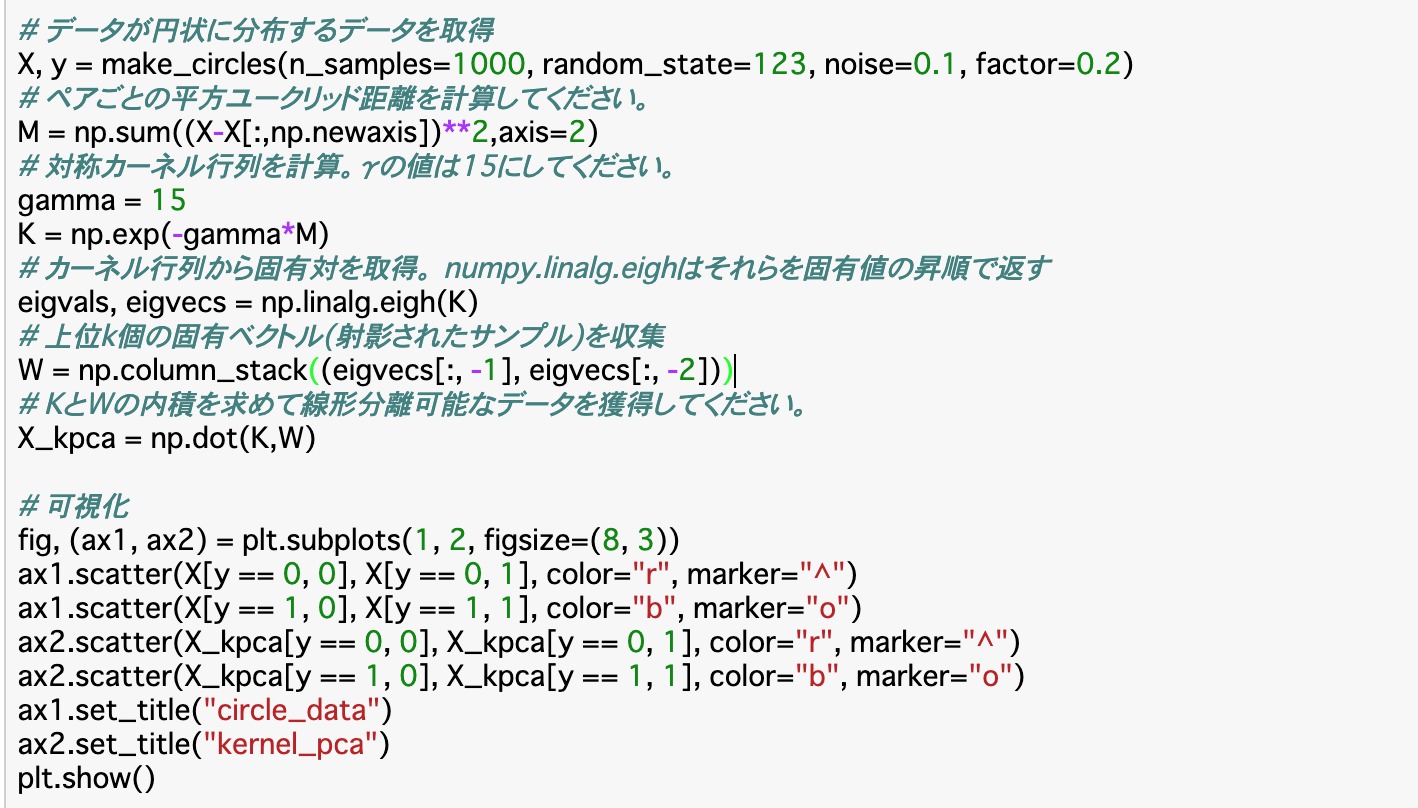

カーネル主成分分析とは

・回帰分析などの機械学習は線形分離を前提としているため、線形分離不可能な

データは扱うことができないが、非線形分離のデータを線形可能なデータに変換するカーネル主成分分析(カーネルPCA)という物を使えば、そのようなデータも扱うことができるようになる。

・カーネルPCAでは、与えられたN(データ数)×M(特徴)のデータを、新しい特徴M'を持ったN×M'のデータKに作り替えるということを行う。これをカーネルトリックと言い、Kをカーネル行列という。

・このカーネル行列Kは主成分分析をすることが可能となる。カーネルトリックについて

・カーネルトリックを行うには、まずカーネル行列Kを算出する必要がある。元のデータがN(データ数)×M(特徴)ならば、KはN×Nとなる。

・カーネル行列は「データのペアごとの類似度」を計算したカーネル関数を行列にした物である。

・このカーネル関数は数種類あるが、今回はその中の動径基底関数(カーネル)のガウスカーネルについて見ていく。

・カーネル関数の一つガウスカーネルは以下のようにして計算できる。#データ同士の平方ユークリッド距離を計算 M = np.sum((X - X[:,np.newaxis])**2, axis=2) #Mを使ってカーネル行列を計算 K = np.exp(-gamma*M)カーネルトリックしたデータを主成分分析

・先述の通り、カーネルトリックを行って取得したカーネル行列Kは、主成分分析を行うことができる。

・主成分分析を行うことで、元は線形分離不可能だったデータXを、線形分離可能なデータX'に変換することができる。カーネル主成分分析を簡単に行う

・KernelPCAというscikit-learnのクラスを使うことで簡単にカーネル主成分分析を行うことができる。

・引数については、n_componentsが圧縮後の次元数、kernelが動径基底関数(カーネル)、gammaがカーネル行列の算出に使われる「γ」の値を示す。from sklearn.decomposition import KernelPCA #KernelPCAインスタンスを作成し、主成分分析する kpca = KernelPCA(n_components=2, kernel="rbf", gamma=15) X_kpca = kpca.fit_transform(X)まとめ

・主成分分析によってデータの圧縮(次元削減)を行うことで、平面上に描画したり、回帰分析の精度を上げたりすることができる。

・主成分分析は、PCAクラスを呼び出すことで簡単に行える。

・動径基底関数(カーネル)によってデータを変換することで、線形分離不可能なデータに対して主成分分析を行うことができる。これによって、線形分離不可能なデータが線形分離可能となり、機械学習が可能になる。これをカーネル主成分分析という。

・カーネル主成分分析はKernelPCAクラスを呼び出すことで簡単に行える。今回は以上です。最後まで読んでいただき、ありがとうございました。

- 投稿日:2020-10-12T23:48:30+09:00

教師なし学習2 非階層的クラスタリング

Aidemy 2020/10/29

はじめに

こんにちは、んがょぺです!バリバリの文系ですが、AIの可能性に興味を持ったのがきっかけで、AI特化型スクール「Aidemy」に通い、勉強しています。ここで得られた知識を皆さんと共有したいと思い、Qiitaでまとめています。以前のまとめ記事も多くの方に読んでいただけてとても嬉しいです。ありがとうございます!

今回は、教師なし学習の2つ目の投稿になります。どうぞよろしくお願いします。*本記事は「Aidemy」での学習内容を「自分の言葉で」まとめたものになります。表現の間違いや勘違いを含む可能性があります。ご了承ください。

今回学ぶこと

・クラスタリングの種類

・k-means法

・DBSCAN法クラスタリング

階層的クラスタリング

・階層的クラスタリングとは、データの中から最も似ている(近い)データをクラスター化していく手法である。

・例えば、a=1,b=2,c=10,d=15,e=100のデータがあったとすると

「(a,b),c,d,e」=>「(a,b),(c,d),e」=>「((a,b),(c,d)),e」=>「(((a,b),(c,d)),e)」

のようにクラスター化し、最終的に全データがまとめられたら終了となる。

・この時、まとまりごとに階層を形成するので、階層的クラスタリングという。非階層的クラスタリング

・非階層的クラスタリングも、階層的クラスタリングと同様、最も似ている(近い)データをクラスター化していく手法であるが、階層構造を作らない。

・非階層的クラスタリングでは、人が幾つクラスターを作るかを決め、それに従ってクラスターが生成される。

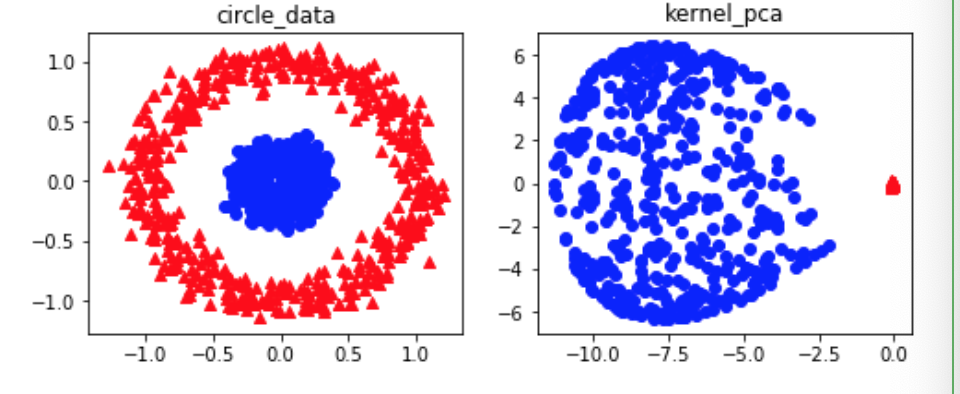

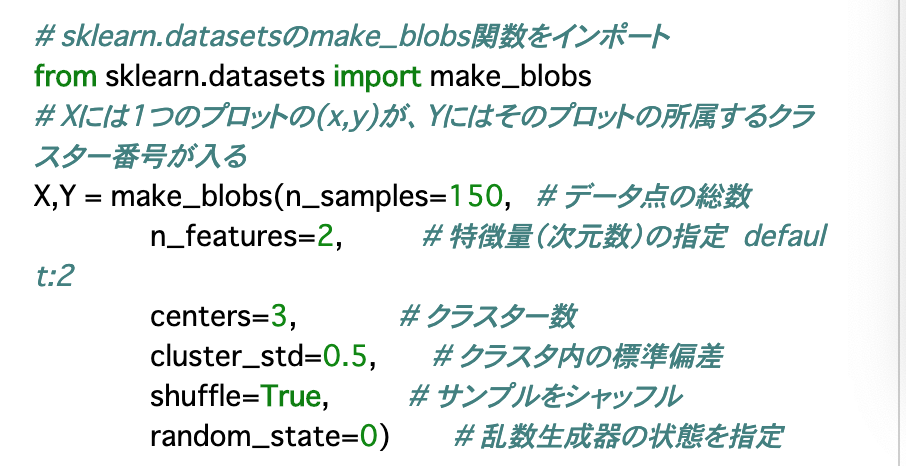

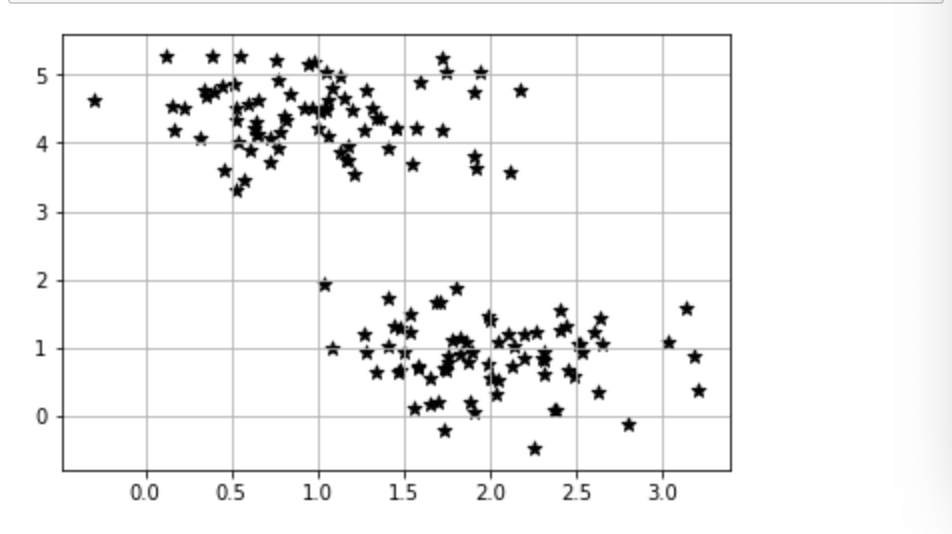

・非階層的クラスタリングは、階層的クラスタリングよりも計算量が少なくて済むので、データ量が多い時に有効である。クラスタリングに使うデータの構造

・make_blobs()を使うことで、クラスター数などを指定してデータを生成できる。

・変数のうち、Xにはデータの点(x,y)が、Yにはクラスターのラベルが入る。

・各引数について

n_samples:データの総数

n_features:特徴量(次元数)

centers:クラスター数

cluster_std:クラスター内の標準偏差

shuffle:データをランダムに並べ替えるかどうか

random_state:seed設定k-means法

・k-means法は非階層的クラスタリングの一つである。クラスタリングの仕方としては、分散の等しいクラスターに分けることで行われる。

・分け方は、SSEと呼ばれる指標を使う。SSEとは、クラスターごとの重心(セントロイド)とデータ点との差の二乗和(=分散)のことである。(詳細は後述)

・そして、この分散(SSE)が最小となるような重心(セントロイド)を学習、選択する。・k_means法の具体的な流れは以下のようになる。

①データの中からk個のデータを抽出し、それらを初期のセントロイドとする。

②全てのデータ点を、最も近いセントロイドに割りふる。

③各セントロイドに集まったデータ群の重心を計算し、その重心を新しいセントロイドとしてセットする。

④元のセントロイドと新しいセントロイドの距離を計算し、近づくまで②③を反復する。

⑤距離が十分近づいたら終了。k-means法の実行

・k-means法を実行するには、KMeans()を使う。引数は以下を参照。

n_clusters:クラスターの個数(make_blobの「centers」に合わせる)

init:初期セントロイドの設定方法("random"でランダムにセットされる)

n_init:上記①を何回行うか

max_iter:上記②③の反復の最大回数

tol:「収束」しているとみなす許容度

random_state:初期seedSSEについて

・SSEは「クラスターごとの重心(セントロイド)とデータ点との差の二乗和(=分散)のことである」と説明したが、この指標をクラスタリングの性能評価に使うこともできる。

・SSEからわかるのは「各データと重心がどれだけずれているか」であるため、値が小さいほどクラスターがまとまっている良いモデルと言える。・SSEの値を表示させるには、

print("Distortion: %2f"% km.inertia_)

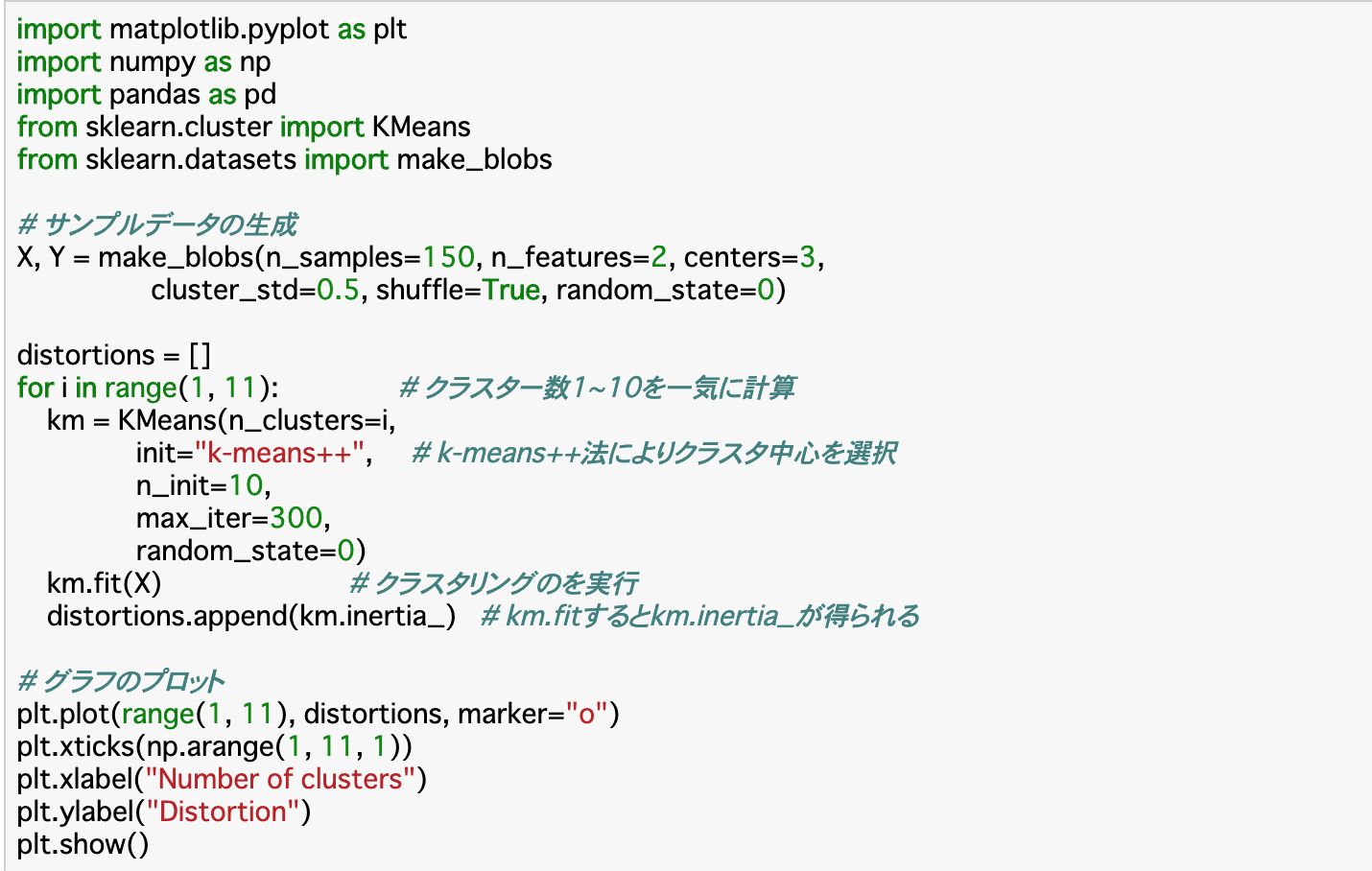

とすれば良い。(kmは前項で作ったKMeansインスタンス)エルボー法

・k-means法ではクラスター数を自分で定める必要があるが、クラスター数決定の際に参考になる手法がある。これがエルボー法と呼ばれるものである。

・エルボー法は、「クラスター数を大きくして行った時のSSEの値」を図式化したものである。

・この図ではSSEの値が折れ曲がる点があり、この点を最適なクラスター数とみなして算出する。この折れ曲がり方が肘のようであることから、エルボー法と呼ばれる。その他の非階層的クラスタリング

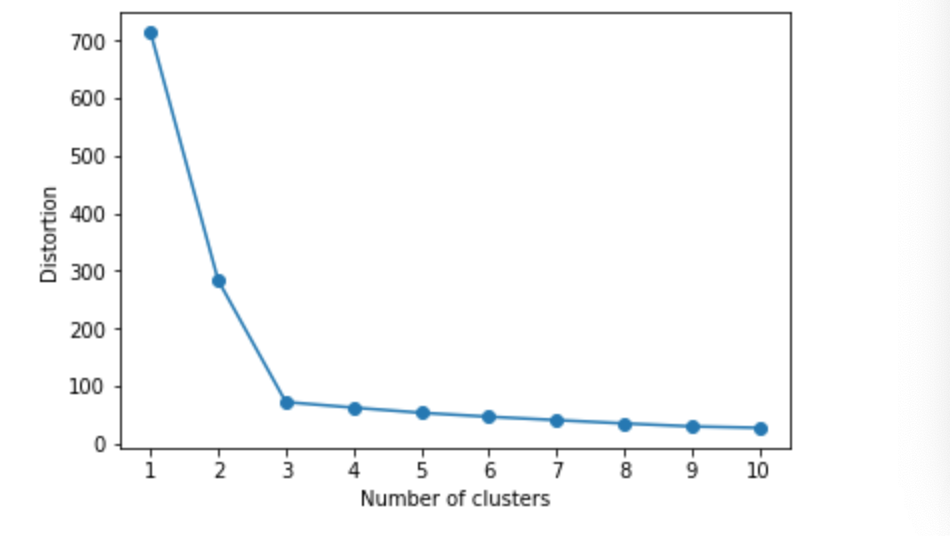

DBSCAN

・非階層的クラスタリングの一例としてk-means法を見てきたが、特徴としては、各クラスターの重心の周囲にデータが集まってくるので、クラスターは円形に近い形になる。そのため、クラスターの大きさや形に偏りがない時にはクラスタリングの精度が上がりやすいが、そうでないと良いクラスタリングにならない。

・このような時に使えるのが、DBSCANという方法である。

・DBSCANは、データが一定数以上集まっているところを中心とし、その周囲にあるデータとそれ以外のデータで切り分ける手法である。

・具体的には、「min_sample」と「eps」という二つの指標を使って行う。手順は以下のとおり。

①データの半径「eps」内にデータが「min_sample」個以上ある場合は、その点をコア点とみなす。

②コア点から、半径「eps」内にあるデータをボーダー点とみなす。

③コア点でもボーダー点でもない点はノイズ点とみなす。

④コア点の集まりをクラスターとみなし、ボーター点を最も近いクラスターに組み込んで終了。・このように、DBSCANではデータを三種類に分けて分類することから、偏ったデータでも良いクラスタリングが行える。

・DBSCANを実行するにはDBSCAN()を使えば良い。(以下のmetric="euclidean"はユークリッド距離を使うという宣言)

まとめ

・クラスタリングには、階層的クラスタリングと、非階層的クラスタリングがある。アルゴリズム上、非階層的クラスタリングは手動でクラスター数を設定する必要がある。

・非階層的クラスタリングの一つにはk-means法がある。k-means法では重心の設定を反復させることでクラスターを生成する。

・k-means法の性能指標にはSSEが使える。値が小さいほどクラスタリングがうまく行っていると言える。

・クラスター数とSSEの関係をプロットしたエルボー法によって、最適なクラスター数を算出できる。

・非階層的クラスタリングのもう一つの手法として、DBSCANがある。DBSCANはある範囲のデータ数を参考にしてクラスターを生成するので、偏ったデータでもクラスタリングがうまく行きやすい。今回は以上です。最後まで読んでいただき、ありがとうございました。

- 投稿日:2020-10-12T23:48:14+09:00

教師なし学習1 基礎編

Aidemy 2020/10/28

はじめに

こんにちは、んがょぺです!バリバリの文系ですが、AIの可能性に興味を持ったのがきっかけで、AI特化型スクール「Aidemy」に通い、勉強しています。ここで得られた知識を皆さんと共有したいと思い、Qiitaでまとめています。以前のまとめ記事も多くの方に読んでいただけてとても嬉しいです。ありがとうございます!

今回は、教師なし学習の投稿になります。どうぞよろしくお願いします。*本記事は「Aidemy」での学習内容を「自分の言葉で」まとめたものになります。表現の間違いや勘違いを含む可能性があります。ご了承ください。

今回学ぶこと

・教師なし学習について

・教師なし学習の種類

・数学的な事前知識教師なし学習

教師なし学習とは

・教師あり学習は、クラスラベルと呼ばれる「答え」が与えられて学習が行われるが、教師なし学習はこの答えを渡さず、コンピュータ自身が判断して学習するものである。

・今回は、この教師なし学習の中の「クラスタリング」と「主成分分析」という手法について学ぶ。クラスタリング

・クラスタリングとは、データを塊(クラスター)ごとに分割する手法である。

・クラスタリングの一手法である「k-means法」は、人がクラスターの個数を決め、コンピュータがその個数になるようにデータを分割するものである。

・また、k-means法では「重心」と呼ばれる点の位置が適切になるように学習し、これに基づいてクラスタリングを行う。主成分分析

・主成分分析とは、データの次元を減らして(次元削減)一つのグラフに情報を集約させる手法である。

・主成分分析では、データの特徴を特に示す(主成分)軸を学習し、定めるという流れで行われる。

・例えば、「年齢、身長、体重」の3つの異なるデータから軸を定め、「個人データ」という形で2次元のグラフで表すというものが挙げられる。教師なし学習の事前知識

ユークリッド距離

・二次元空間上の二点(x1,x2),(y1,y2)間の座標距離は

$\sqrt{(x_1-y_1)^2+(x_2-y_2)^2}$

で求めることができる。

・同様にn次元空間上の2点(x1,x2...xn),(y1,y2...yn)間の距離は

$\sqrt{(x_1-y_1)^2+(x_2-y_2)^2+...+(x_n-y_n)^2}$

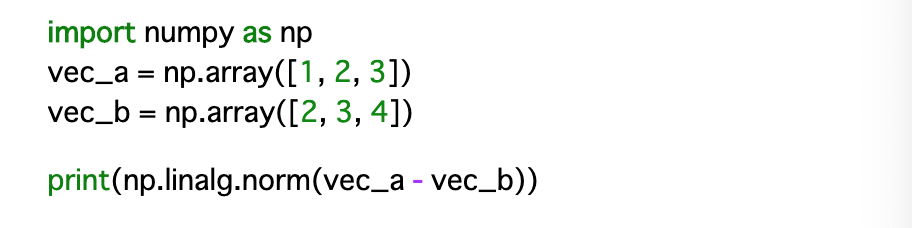

で求められる。この距離のことをユークリッド距離(ノルム)という。・以下のように、NumPyでユークリッド距離を求められる。(np.linalg.norm() は「()内の二乗の和」を表す)

コサイン類似度

・二つのベクトルがどのぐらい似ているかを評価するとき、「長さ」と「方向」の類似性から判断される。

・このうち方向に注目すると、二つのベクトルの作る角度「θ」が小さければ小さいほど類似性が高いと言える。

・θの求め方としては、ベクトルの内積の公式 $\vec{a} \cdot \vec{b} = |\vec{a}|\, |\vec{b}| \, \mathrm{cos}\theta$ を発展させて、cosθを求めることでわかる。この手法のことを「コサイン類似度」という。

・この時のcosθであるが、cosθは値が大きいほどθが小さくなることに注意。

・また、コサイン類似度もn次元のデータに対応している。・コードでは、NumPyで求めることができる。(np.dot()は「各要素の積の総和」を表す(以下で言うと、1*2+2*3+3*4))

まとめ

・教師なし学習は正解ラベルを渡さずにコンピュータ自身が判断し学習する手法である。

・教師なし学習には「クラスタリング」と「主成分分析」がある。前者はデータをクラスターごとに分割する手法であり、後者は、次元削減することで一つのグラフに情報を集約させる手法である。

・教師なし学習では、「ユークリッド距離(ノルム)」や「コサイン類似度」でデータの類似性などを判断することがある。今回は以上です。最後まで読んでいただき、ありがとうございました。

- 投稿日:2020-10-12T23:47:53+09:00

教師あり学習(回帰) 2 応用編

Aidemy 2020/10/28

はじめに

こんにちは、んがょぺです!バリバリの文系ですが、AIの可能性に興味を持ったのがきっかけで、AI特化型スクール「Aidemy」に通い、勉強しています。ここで得られた知識を皆さんと共有したいと思い、Qiitaでまとめています。以前のまとめ記事も多くの方に読んでいただけてとても嬉しいです。ありがとうございます!

今回は、教師あり学習の二つ目の投稿になります。どうぞよろしくお願いします。*本記事は「Aidemy」での学習内容を「自分の言葉で」まとめたものになります。表現の間違いや勘違いを含む可能性があります。ご了承ください。

今回学ぶこと

・モデルの汎化についてモデルの汎化

(復習)汎化とは

・回帰分析での予測は関数に基づいたものであるが、実際の価格変動には幅があり、入力データが同じでも結果が異なることもままある。

・このような前提のもとで、モデルが過去のデータを信頼しすぎると予測が破綻してしまうことになる。これを過学習と言い、過学習を防ぐことを汎化という。正則化

・線形回帰における汎化の手段として、正則化というものが用いられる。正則化とは、モデルの複雑性にペナルティを設け、モデルを一般化しようとすることである。

・正則化には「L1正則化」と「L2正則化」の2種類がある。

・L1正則化とは、予測に対する影響が小さいであろうデータの係数を0に近づけることで、余分な情報を削減して正則化を行う。

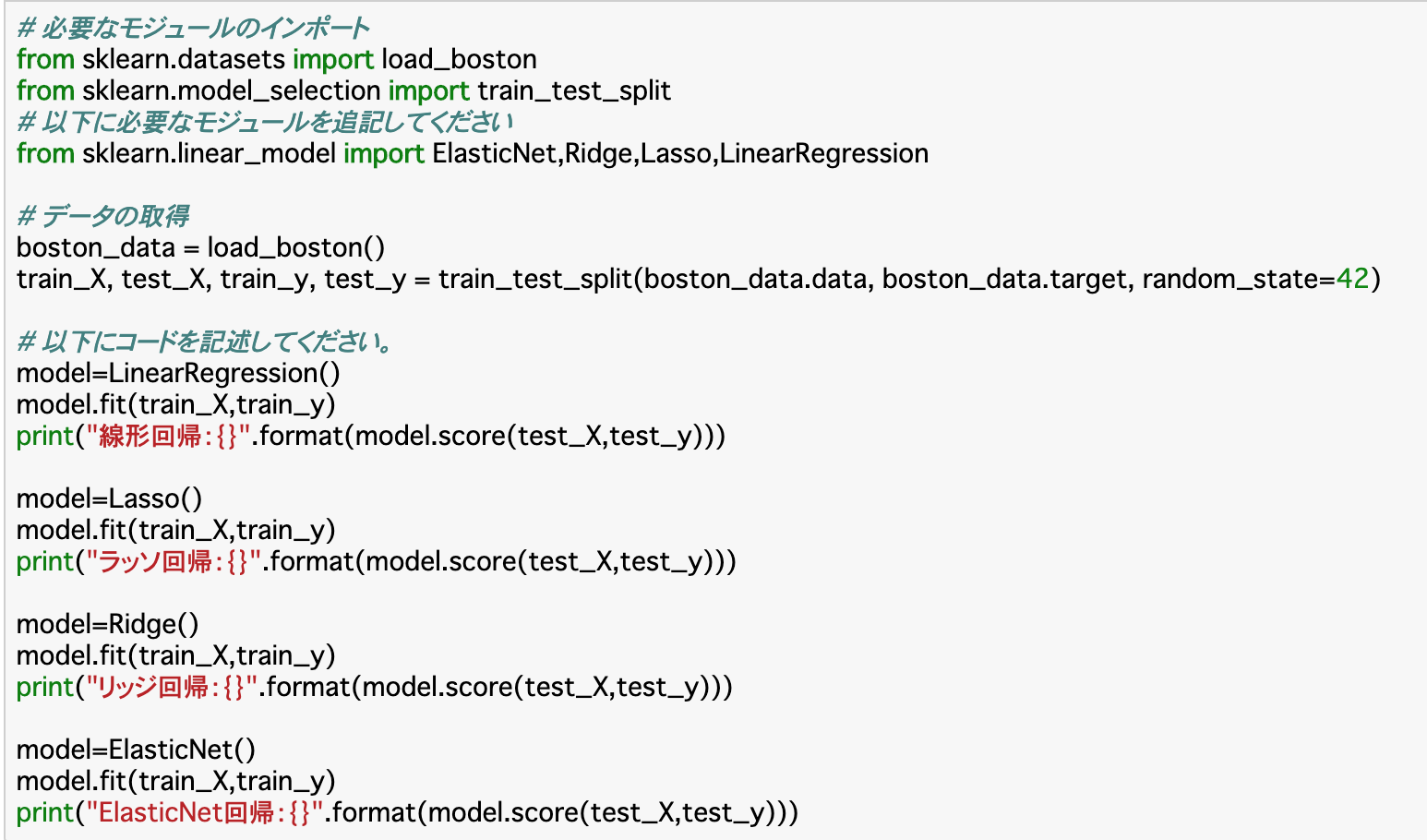

・L2正則化とは、係数の大きさに制限を設けることで、過学習を防いで正則化を行う。ラッソ回帰

・ラッソ回帰とは、L1正則化を使う回帰モデルを指す。

・L1正則化は、余分な情報が多い時に高い効果があるので、例えばデータ数(行数)に対するパラメータ数(列数)が多いときなどにラッソ回帰が使われる。

・ラッソ回帰の使い方は、model=Lasso()のようにすれば良い。リッジ回帰

・リッジ回帰とは、L2正則化を使う回帰モデルを指す。

・L2正則化は、係数の範囲に上限ができるため、汎化されやすい。

・リッジ回帰の使い方は、model=Ridge()のようにすれば良い。ElasticNet回帰

・ElasticNet回帰とは、L1正則化とL2正則化を組み合わせて使う回帰モデルを指す。

・L1正則化の情報を取捨選択してくれる点と、L2正則化の汎化されやすい点を持つので、メリットが大きい。

・ElasticNet回帰の使い方は、model=ElasticNet()とすれば良い。

・また、引数に「l1_ratio=0.3」などのように指定すれば、L1正則化とL2正則化の割合を指定できる。まとめ

・線形回帰における汎化の手段には、正則化がある。

・正則化にはL1正則化とL2正則化があり、前者を使った回帰がラッソ回帰、後者がリッジ回帰、両方を使った回帰がElasticNet回帰と呼ばれる。今回は以上です。最後まで読んでいただき、ありがとうございました。

- 投稿日:2020-10-12T23:47:36+09:00

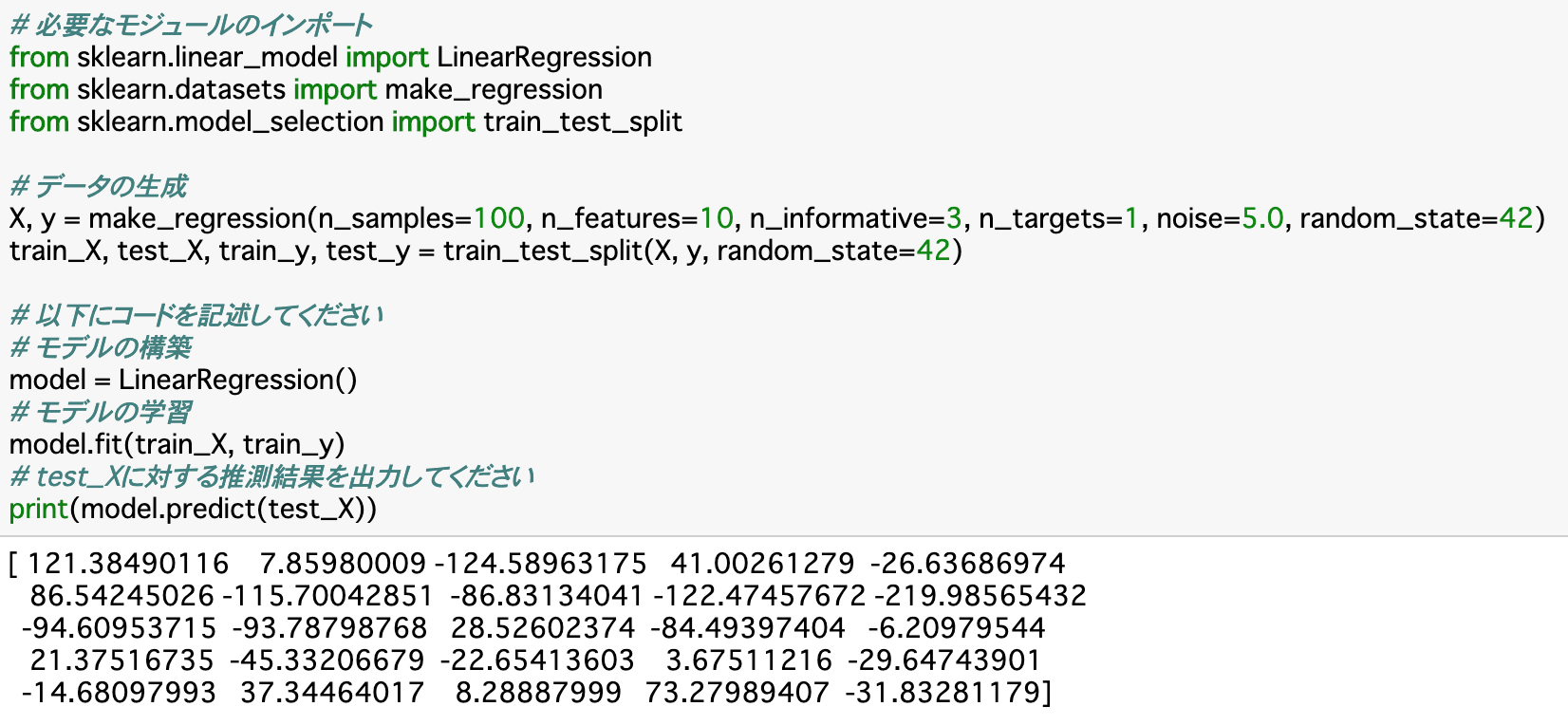

教師あり学習(回帰)1 基礎編

Aidemy 2020/10/28

はじめに

こんにちは、んがょぺです!バリバリの文系ですが、AIの可能性に興味を持ったのがきっかけで、AI特化型スクール「Aidemy」に通い、勉強しています。ここで得られた知識を皆さんと共有したいと思い、Qiitaでまとめています。以前のまとめ記事も多くの方に読んでいただけてとても嬉しいです。ありがとうございます!

今回は、教師あり学習(回帰)の一つ目の投稿になります。どうぞよろしくお願いします。*本記事は「Aidemy」での学習内容を「自分の言葉で」まとめたものになります。表現の間違いや勘違いを含む可能性があります。ご了承ください。

今回学ぶこと

・教師あり学習(回帰)について

・線形回帰の方法教師あり学習(回帰)

(復習)機械学習の手法

・機械学習には3つの手法がある。「教師あり学習」「教師なし学習」「強化学習」である。

・このうち、教師あり学習は「分類」「回帰」の二つに分けられる。今回学ぶ回帰は、株価や時価などの連続値を予測する。線形回帰

線形回帰とは

・線形回帰とは、既に分かっているデータの式(グラフ=線形)から、その先のデータの動きを予測するものである。この時のグラフは必ず直線(一次関数)になる。

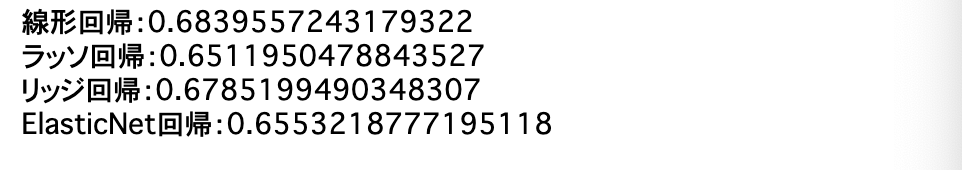

決定係数

・決定係数とは、線形回帰で予測したデータと実際のデータがどのぐらい一致しているかを示すものである。

・教師あり学習に使われるscikit-learnのおいては決定係数は0〜1の値をとる。数値が大きいほど一致度は高いと言える。

・決定係数を出力するときはprint(model.score(test_X,test_y))のようにすれば良い。線形単回帰

・線形単回帰とは、1つの予測したいデータ(y)を1つのデータ(x)から求める線形回帰のことである。

・すなわち、データが「y=ax+b」で表せると仮定して、aとbを推測することを指す。

・aとbの推測には、一つには、最小二乗法というものが使われる。これは、実際のyと推定するy(つまりax+b)の差の二乗の総和が最小になるようなaとbを設定するというものである。

・この方法で差を二乗するのは、データの正負を考慮しなくて良いからである。・線形(単)回帰を使うには、「model=LinearRegression()」のようにすればよい。

線形重回帰

・線形重回帰とは、予測したいデータが1つ(y)に対し、予測に用いるデータが複数個(x1,x2...)となる線形回帰のことである。

・すなわち、データが「y = a1x1 + a2x2... +b」で表せると仮定して、aとbを推測することを指す。

・線形重回帰でも、aとbの予測は最小二乗法で行われる。

・また、使うのも、LinearRegression()で良い。単回帰か重回帰を自動で判断してくれる。まとめ

・教師あり学習(回帰)の一つである線形回帰とは、既に分かっているデータの式(グラフ=線形)から、その先のデータの動きを予測するものである。

・線形回帰には、予測するものが一つである「線形単回帰」と複数である「線形重回帰」がある。今回は以上です。最後まで読んでいただき、ありがとうございました。

- 投稿日:2020-10-12T23:40:20+09:00

【Python】自動フォルダ作成ツールを開発してみた!

はじめに

前回の記事で自動でフォルダを作成してくれるコードを書きましたが、GUI化して、操作しやすいようにした方が複数のフォルダを作成するときに、楽だと思ったので作成してみることにしました。

環境

実行は以下の環境で行いました。

Windows 10 version 1903

Python 3.7.6

PyInstaller 3.6完成品

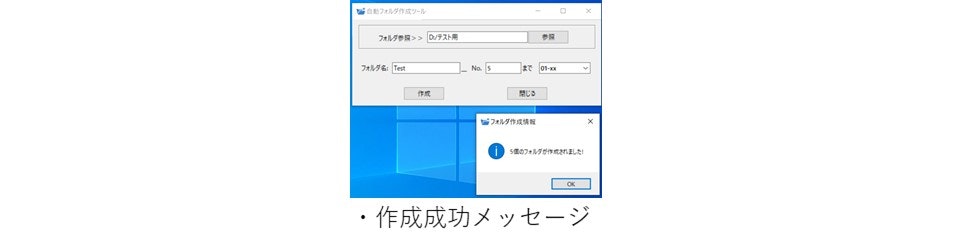

パスを指定して、フォルダ名とフォルダを何個まで作成するかを入力します。

次に、数字の種類を選び、「作成」ボタンを押します。

すると、指定した分の数だけフォルダが作成されます。

フォルダ名の表記はex.『No.1~No.100』を選択、フォルダ名[Test]_No.[5]までを指定すると、Test_No.1 Test_No.2 Test_No.3 Test_No.4 Test_No.5のように作成されます。

数字の表記は

- 『01~100』までの数字

- 『No.1~No.100』までの数字

- 『One~One_Hundred』までの英語表記の数字

- 『一~百』までの漢字表記の数字

- 『I~C』のローマ数字

となっております。英語表記と漢字表記の数字は自動ソートがされないので使い勝手が悪いです。

今回、フォルダの個数は誤入力が起こらないように100個までに制限しています。

また、フォルダ名を入力しない場合でも、パスとフォルダの数の指定があれば、作成され、同じフォルダ名があったとき、作成個数が違った場合、作成されないです。※注意点として、何回もフォルダを作成・削除して、デフラグを起こさないように!!

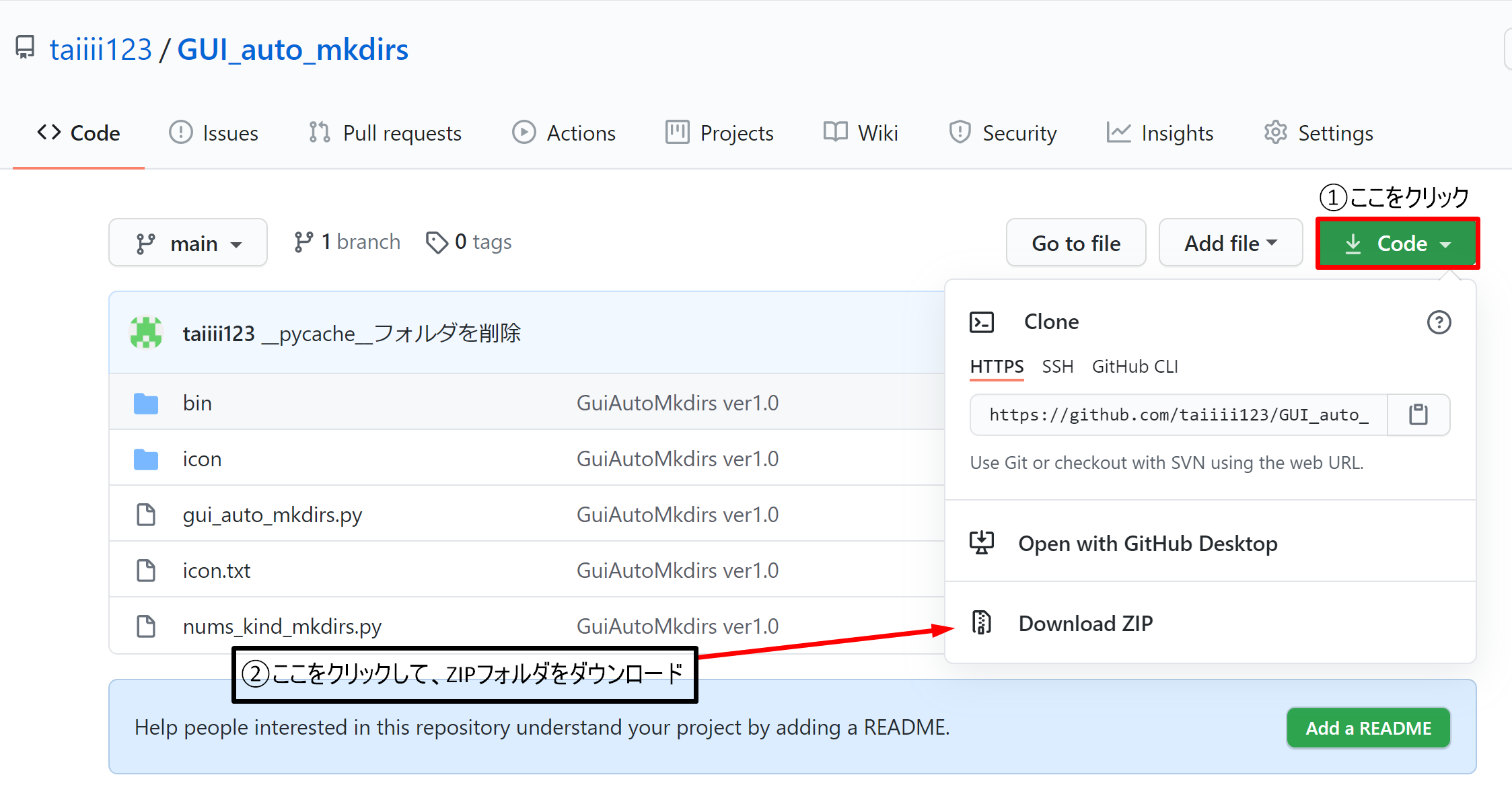

ツールが欲しい方

GitHubにプッシュしたので、下のURLからダウンロードしてください。

ダウンロード方法

- 上記のURLからGithubにアクセスして頂き、右上のCodeをクリックします。

- 「Download ZIP」という項目が表示されるので、その項目をクリック。クリックすると、ZIPフォルダがダウンロードされます。

- ダウンロードしたZIPフォルダを解凍して頂き、binフォルダにある「gui_auto_mkdirs.exe」の実行ファイルが確認できたら完了です。

- 最後は、実行ファイルを起動することを確認したら、任意の場所にフォルダを作成してみてください。

実装内容

設計

今回、Pythonの標準ライブラリであるTkinterを使いました。サードパーティ製ライブラリであるkivyというライブラリが人気らしいですが、Tkinterの方が参考文献がたくさんあったのでTkinterを選びました。

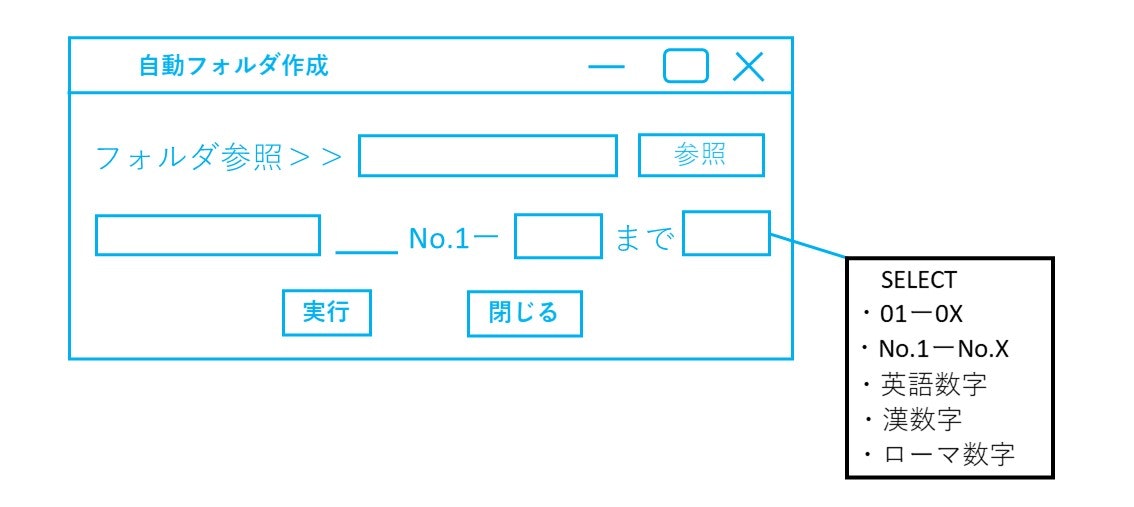

自動フォルダ作成ツールを考えたときに、まず、設計から考えました。

- デザインやレイアウト等

- 条件処理について

- クリック処理について

デザインはまず、どうするかを考え、「参考記事【Python】tkinterでファイル&フォルダパス指定画面を作成する」をもとにデザインを考えました。

こんな感じで作っていこうと考えました。

次に、何個まで作成するか等の条件を考えました。入力の桁を打ち間違ったときに、何千個と作成されないように100個までという条件を付けました。また、「SELECT」ボタンですが、本当は実装する予定がなく、ただディレクトリ名と数字だけだと機能が少ないなと思い、「No.1~No.100」以外で選択できるように実装しようと考えました。

最後に、ユーザーが選択して、「作成」ボタンを押したときにフォルダ作成されるように実装していこうと考えました。

コードについて

全コード?Github

まず、Tkinterのレイアウト等を決めるPythonファイルとディレクトリ作成用の関数がもとまったPythonファイルに分けることにしました。

ディレクトリ作成用のPythonファイルから、

『01~100』と『No.1~No.100』は数字の部分でfor文のint型でそれぞれ処理できるのですが、英語表記の数字、漢数字、ローマ数字は文字列として扱うので、それぞれの1から100までのタプル形式で用意しました。リストにしなかったのは、後から変更しないためです。例ENG_NUMS = ( "One", "Two", "Three",‥‥, "One_Hundred")用意した番号の一覧をもとに、ディレクトリを作成する関数を作っていきます。

def mkdir_eng_nums(dirPath, dir_name, dir_count): for count in range(0, int(dir_count)): os.mkdir(dirPath + '/' + '{}_{}'.format(dir_name, ENG_NUMS[count]))引数に、それぞれ、パスを指定した絶対パス、入力したディレクトリ名、入力した作成個数の指定として、

dir_countをint型にキャストし、for文で回しています。for文内の処理は、osモジュールのmkdir関数をつかって、指定した絶対パスとディレクトリ名とタプルの中身を連結することで、1個ずつディレクトリを作成していきます。他の数字や漢数字等は同様な原理で作成しています。続いて、メインとなるレイアウト等のPythonファイルですが、まずは、osやtkinterモジュール等をインポート。

import os,sys from tkinter import * from tkinter import ttk from tkinter import messagebox from tkinter import filedialog from nums_kind_mkdirs import *次に、フォルダ参照ですが、以下のように処理しています。

entry1 = StringVar() IDirEntry = ttk.Entry(frame1, textvariable=entry1, width=30) IDirEntry.pack(side=LEFT) IDirButton = ttk.Button(frame1, text="参照", command=dirdialog_clicked) IDirButton.pack(side=LEFT)ボタンのオブジェクトを設置し、ボタンを押したときに、

dirdialog_clicked関数を呼び出しています。dirdialog_clicked関数内は、ユーザーがディレクトリ指定したときに、絶対パスを取得します。また、取得した絶対パスは変数entry1に代入します。

同様に、ファイル名およびディレクトリ個数入力欄も入力したときに、フォルダ名はentry2に、作成個数はentry3に代入しています。また、ドロップダウンリストでは、以下のように処理しています。

nums_kind = ["SERECT", "01-xx", "No.1-No.xx", "英語表記(One~)", "漢数字(一~)", "ローマ数字(I~)"] co = ttk.Combobox(frame2, state="readonly", values=nums_kind, width=12) co.set(nums_kind[0]) co.pack(side=LEFT, padx=(2, 10))

ttk.Comboboxでコンボボックスを作成し、選択肢はリスト型のnums_kindから選びます。co.set(nums_kind[0])で何もしない処理としてデフォルトでSERECTをセットしています。続いて、ディレクトリを作成する処理やエラー処理についてですが、以下のように処理をしています。

try: if dirPath: if int(input_dir_count) <= 100: if co.get() != 'SERECT': if co.get() == '01-xx': mkdir_nums(dirPath, input_dir_name, input_dir_count) elif co.get() == 'No.1-No.xx': mkdir_numbers(dirPath, input_dir_name, input_dir_count) elif co.get() == '英語表記(One~)': mkdir_eng_nums(dirPath, input_dir_name, input_dir_count) elif co.get() == '漢数字(一~)': mkdir_kansuuji(dirPath, input_dir_name, input_dir_count) elif co.get() == 'ローマ数字(I~)': mkdir_roman_numbers(dirPath, input_dir_name, input_dir_count) else: pass text += dirPath else: messagebox.showwarning("警告", "数字の表記が選択されていません") else: messagebox.showwarning("警告", "最大、100個までのフォルダを作成することが可能です") elif not dirPath and not input_dir_name and not input_dir_count: messagebox.showerror("エラー", "何も入力されていません") else: messagebox.showerror("エラー", "パスの指定がありません。")まず、実行ボタンを押したときに、絶対パスが入力され、ディレクトリ作成個数が100個以下という条件だったときに、それぞれのディレクトリを作成する関数を呼び出して、複数のディレクトリを作成していきます。そのとき、入力したパスは文字列になるので、

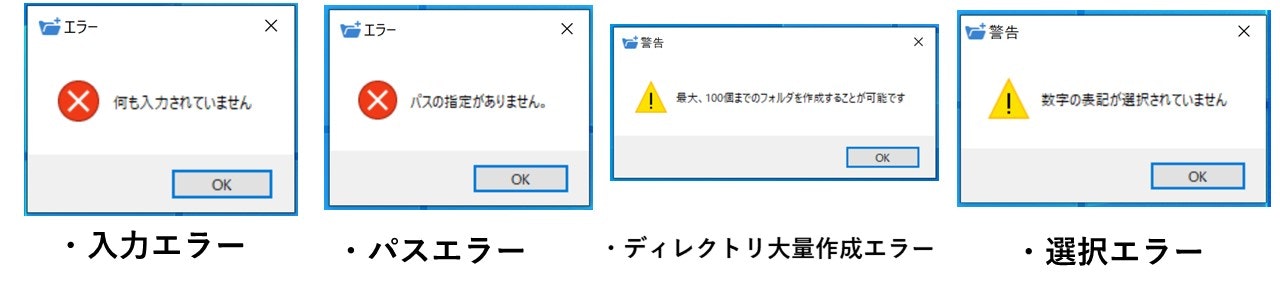

text = ""に代入することで、フォルダ作成メッセージを表示させています。if text: messagebox.showinfo("フォルダ作成情報", "{}個のフォルダが作成されました!".format(input_dir_count))エラー処理については、演算子記号のnotを用いて、3つの入力欄に何も入力していないときの処理として、「入力エラー」を表示させています。また、パスが入力され、フォルダ作成個数が100より大きければ、「ディレクトリ大量作成エラー」を表示させています。さらに、パスが入力され、100個以下の作成条件下でドロップダウンリストが選択されていないとき、「選択エラー」を表示させています。最後に、パス以外の入力がされているとき、「パスエラー」を表示させています。以下にエラー表示パターンを示します。

続いて、例外処理ですが、作成個数入力欄に半角英数字の数字以外を入力すると、ValueErrorが返されるので、ValueErrorが発生したときに、「半角英数字入力エラー」を表示させるようにしています。また、ディレクトリが重複した場合、FileExistsErrorが返されるので、FileExistsErrorが発生したときに、「ディレクトリ作成エラー」を表示させるようにしています。

以下にエラー表示パターンを示します。

もっと、エラー処理について、簡単な書き方がある気がする、、、

最後に、作成ボタンやキャンセルボタンについてですが、以下のように処理をしています。

作成ボタンコードbutton1 = ttk.Button(frame3, text="作成", command=conductMain) button1.pack(fill = "x", padx=85, side = "left")キャンセルボタンコードbutton2 = ttk.Button(frame3, text=("閉じる"), command=root.quit) button2.pack(fill = "x", padx=30, side = "left")作成ボタンを押したときに、

command=でイベントを発生させ、conductMain関数を呼び出しています。その後、条件によって、ディレクトリが作成されます。

また、キャンセルについては、ボタンを押したときに、root.quitでウィンドウを閉じています。長くなりましたが、実装内容は以上となります。

説明が必要ないところも説明したかもしれませんがご容赦ください。つまずいたところ

エラーハンドリング

どこを入力して、入力しないかで思いもよらなかった動作をするので、ちょっと大変でした。

エラーするたびに、条件を変えたり、メッセージを表示させたり、トライ&エラーの繰り返しでした。ディレクトリを作成する関数

作成する関数の部分はちょっと間違えばCドライブ直下に大量にディレクトリが作成されるので、気を付けながら条件等を変えていました。

アイコンの設定

tkinterでは

root = tk.Tk() iconfile = 'アイコンのパス' root.iconbitmap(default=iconfile)のように、記述すると、tkinterで表示される画面のアイコンは設定されるのですが、Pyinstallerでexe化したときにスクリプトが実行されず、アイコンも設定されないので、画像ファイルの拡張子をgifにしてBase64のデータを取得する必要がありました。なので、

terminalcertutil -encode icon.gif text.txtでCUI操作をして、iconデータをテキストファイルに書き出しました。Base64データをコピペしてコードに埋め込むことによって解決しました。また、実行ファイルのアイコンは通常のPyinstallerの操作では

terminalpyinstaller ファイル名.py --onefile --noconsoleですが、このままだとPythonの実行ファイルのアイコンが変えられないので、

terminalpyinstaller gui_auto_mkdir.py --onefile --noconsole --icon=favicon.icoのように

--icon=アイコンファイルを付与しました。そうすることで、Tkinterで表示される画面と実行ファイルのアイコンを設定することが出来ました。参考

- 【Python】tkinterでファイル&フォルダパス指定画面を作成する

- tkinter --- Tcl/Tk の Python インタフェース

- Tkinter 入門: 2. Widget を配置しよう

- Tkinter による GUI プログラミング

- 仕事を自動化する!Python入門講座

終わりに

最後まで、見ていただき、ありがとうございます。

皆さんの、作業効率化にお役に立てれば、嬉しいです。

今回、指定した数だけフォルダを作成する機能を実装しましたが、拡張機能としてチェックボックスを利用したフォルダ作成機能もこれから実装する予定です。

- 投稿日:2020-10-12T23:21:47+09:00

Think Python 2E ハック

Think Python 2E ハック

Think Python 2Eを学んでまともなプログラマーになるためのに

モチベーション

NEXT STEP NEXT STEP

概要

think Python 2e を

問題を含めてハックする。

http://facweb.cs.depaul.edu/sjost/it211/documents/think-python-2nd.pdf目次

・エクササイズノート

エクササイズメモ

CHAPTER 2

Exercise 2-1

省略

Exercise 2-2import math

4 / 3 * math.pi (5*5*5)

523.5987755982989

24.95(100-40) + 3 + 24.95*(100-40)* (60-59)+ 59 * 0.75

3041.257:30:06

- 投稿日:2020-10-12T22:57:55+09:00

'pip' は、内部コマンドまたは外部コマンド、 操作可能なプログラムまたはバッチ ファイルとして認識されていません。

- 投稿日:2020-10-12T21:36:55+09:00

数値を線形探索/2分探索で探してみよう

こんにちは。

いつも応援有難うございます m(_ _)m

9/23 から投稿を開始して、そろそろ 3 週間が経とうとしています。

楽しいことは あっ という間ですね(笑)。さて、今回は探索です。

最初は線形探索から行きましょう。

構えなくて大丈夫です。

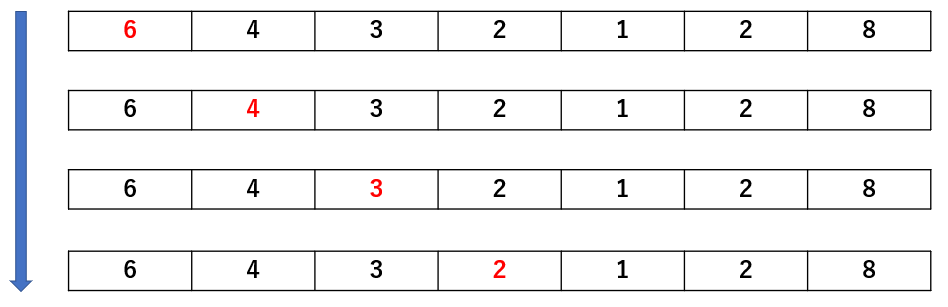

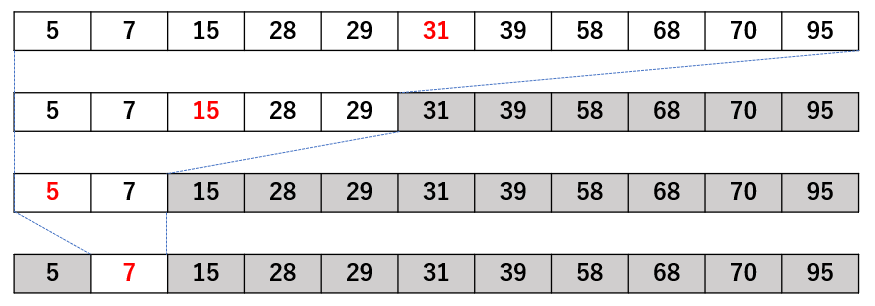

こんな感じで左から順番に、探したい値と赤字が一致しているか確認するだけです。

※すいません、途中で図が切れてて。。

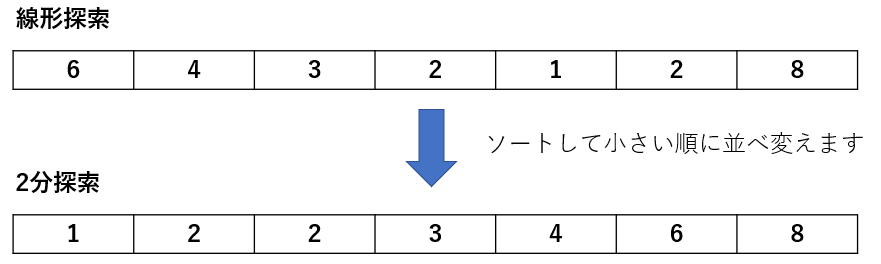

早速、書いてみましょう。linear_search.pydef search(x,key): for i in range(len(x)): if x[i] == key: print(f"value is placed at x[{i}]") break #最終項 x[6] != key の場合、前述の if x[i] == key を pass するので、 #そのまま以下の if 文に入ります。 #i == len(x)-1 なら、fail です。 if i == len(x)-1: print("fail to serch") break if __name__ == "__main__": x = [6,4,3,2,1,2,8] # 配列を指定 key = int(input("enter search value: ")) # 探したい値を入力 search(x,key)では次は、2分探索です。

線形探索との前提条件が大きく異なります。その違いをイメージにしました。

線形探索の場合は、与えられたものを端から比較していくのですが、

2分探索は、そうは行きません。一旦、整列します。出だしが全然違うので注意が必要です。

(? _ ?)(? _ ?)(?_?)

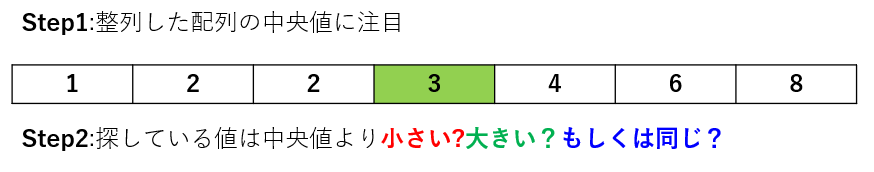

はい、構わず次のステップに行きます。

仮に 3 を探している場合、中央値との比較で一発で発見できます(笑)

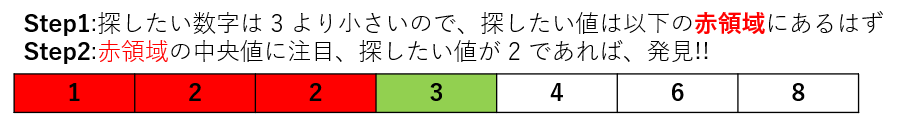

では、3 より小さい値を探している場合はどうでしょうか。

探したい値が1の場合どうしましょうか。

[1 , 2 , 2] の中央値 2 でもない場合は、更にそれ以下の

1 が格納されている x[0] を見るだけです。

もし、それでも探している値が無ければ、探し物はそもそも、

用意された配列には存在しない事になります。

一旦、整理しないとイケないメンドイ アルゴですが、なかなか有名らしいです。

今回は再帰で書いてみました。binary_search.pydef binary_search(x,left,right,key): cen = (left + right)//2 if left > right: print(f"left is {left},right is {right}") print("faile to search") return None if x[cen] == key: return print(f"found at x[{cen}]") #中央値 x[cen] が探し物 key より大きい場合 if x[cen] > key: print(f"left is {left},cen is {cen}") binary_search(x,left,cen-1,key)#cen-1 の "-1" がミソです!!! #中央値 x[cen] が探し物 key より小さい場合 if x[cen] < key: print(f"cen is {cen},right is {right}") binary_search(x,cen+1,right,key)#cen+1 の "+1" がミソです!!! if __name__ == "__main__": x =[1,2,2,3,4,6,8] binary_search(x,0,len(x)-1,1)実行結果.pyleft is 0,cen is 3 left is 0,cen is 1 found at x[0]左側を選択し、徐々に狭めていますね。

配列長を大きくしてイメージを作り直してみました。

このほうが分かりやすいかもしれません(中央値は赤、探し物が 7 の場合)。

もし、探し物が7じゃなかったらどうしますか?

以下の記述のミソに着目してみてください。miso.py#中央値 x[cen] が探し物 key より大きい場合 if x[cen] > key: print(f"left is {left},cen is {cen}") binary_search(x,left,cen-1,key)#cen-1 の "-1" がミソです!!! #中央値 x[cen] が探し物 key より小さい場合 if x[cen] < key: print(f"cen is {cen},right is {right}") binary_search(x,cen+1,right,key)#cen+1 の "+1" がミソです!!!念のため実行してみると以下のコメントが見えてきます。

実行結果.pyleft is 5,right is 4 faile to searchそうなんです。left > right が実現しています。

どういう事でしょうか?探し物が 6 だった場合、

記述にある if x[cen] > key:に突入します。その結果、binary_search(x,left,cen-1,key) となります。

この時点で、left == right なので、前述の式を考えると

left > right になりますよね!??。

これが逆転の仕組みです。

ここまで来たら、何もないって言えますよね??

※逆のパターン(if x[cen] < key:)もしかりです(≧▽≦)もっとシンプルに書ける方が居たら、

申し訳ありませんが御教示宜しくお願い致します。m(_ _)m

- 投稿日:2020-10-12T21:12:35+09:00

Python3のExecutor.submitを大量に実行するとメモリを多く消費する場合がある

参考にしました: https://www.bettercodebytes.com/theadpoolexecutor-with-a-bounded-queue-in-python/

概要

Executorでmax_workersを指定すると並列度が調整できますが、並列数を上回るペースでsubmitした場合にどうなるかというとブロックは起きません。その代わりメモリにため込むようです。この動きのため、大量に実行するとメモリを多く消費してしまうことがあります。

with ThreadPoolExecutor(max_workers=10) as executor: for i in range(0, 1024*1024): # たくさん executor.submit(fn, i) # つくる # forループはすぐ終わるが、消費メモリがすごいことになっている実際、100万ループするようなコードを書くとメモリを2GBぐらい消費します。なので、対応を考えることにしました。

内部実装と原因

内部実装を確認したところ、ThreadPoolExecutorは内部でキューを持っており、submitするとWorkItemというオブジェクトを作りキューに入れます。この内部のキューには上限が無くブロックすることもないため、際限なくsubmitできてしまいます。

ちなみに、Workerスレッドはキューに詰めたタイミングで作っていて、Workerスレッドはキューからデータを取り出し、実行、というのを無限ループでやっています。

確認コード

実際にその動きを観察してみます。例えば0.01秒かかる関数を5000回実行します。これをmax_workers=10で回してみます。

for文内での進捗としてタイムスタンプとメモリ(今回はmaxrss)を見ます。

https://wandbox.org/permlink/n2P2CQssjhj1eOFw

タイムスタンプからsubmitでブロッキングは起きていないことがわかります(forループのsubmitする処理はすぐに終えてほとんどshutdown待ちになっている)

しかし、処理が進むにつれメモリ消費が増えていることがわかります。対応

案1. キューをサイズ付きにする

最初に考えたのはこの方法です。

ThreadPoolExecutorの内部で使うキューをサイズ付きのキューにします。継承してインスタンス変数をすり替えます。https://wandbox.org/permlink/HJN0lRBR0VBYU0Pv

タイムスタンプからループ中にブロッキングが起きていることがわかります。しかしトータルの時間はさほど変わらずメモリの消費は非常に緩やかです。

コードは単純ですが、内部実装に手を出すのは若干いまいちな感じがしますし、ProcessPoolExecutorではこういったキューは持っていないので、この方法は使えません。

案2. Semaphoreで同時実行数を制御する

案1がいまいちだったのでどうにかできないか探していたところ参考元の記事を見つけました。

https://www.bettercodebytes.com/theadpoolexecutor-with-a-bounded-queue-in-python/

参考元を参考にPoolExecutorをラップしたクラスBoundedExecutorを作成します。API互換(map以外)なので差し替えて使えます。

内部実装はsubmit時にsemaphoreのカウントダウンを行い、ワーカーの処理が完了したときはsemaphoreのカウントアップをすること同時実行を制御します。「ワーカーの処理が完了したとき」というのは「futureのadd_done_callbackで登録した関数が完了時に呼ばれるとき」とします。(ワーカーの処理が完了した時もraise Exceptionした時もコールバックは呼ばれるので辻褄は合うはず)

https://wandbox.org/permlink/jn4nN8leJonLi2ty

こちらも、案1のときと同様な結果になりました。

ちなみに、max_workersよりも多くなるようにキューのサイズを決めたほうが良いです(コードで言えばbounded_ratio=1の箇所がbounded_ratio=2になるように引数を与えるor変える)

「並列数==キューのサイズ」にしてしまうと、キューに空きができてしまうタイミングが発生してしまい、ワーカーが遊んでしまい全体の完了が若干遅くなります。なので、少し多くなるようにするのがよいです。

- 投稿日:2020-10-12T21:02:02+09:00

異常検出の基本的な流れ

1. 前処理

KaggleのCredit Card Fraud Detectionを利用する。

import numpy as np import pandas as pd import os import matplotlib.pyplot as plt import seaborn as sns import matplotlib as mpl from sklearn import preprocessing as pp from scipy.stats import pearsonr from sklearn.model_selection import train_test_split from sklearn.model_selection import StratifiedKFold from sklearn.metrics import log_loss from sklearn.metrics import precision_recall_curve, average_precision_score from sklearn.metrics import roc_curve, auc, roc_auc_score from sklearn.metrics import confusion_matrix, classification_report from sklearn.linear_model import LogisticRegression from sklearn.ensemble import RandomForestClassifier import xgboost as xgb import lightgbm as lgb %matplotlib inline data = pd.read_csv('creditcard.csv') print(data.shape) print(data.columns) print(data.dtypes)(284807, 31) Index(['Time', 'V1', 'V2', 'V3', 'V4', 'V5', 'V6', 'V7', 'V8', 'V9', 'V10', 'V11', 'V12', 'V13', 'V14', 'V15', 'V16', 'V17', 'V18', 'V19', 'V20', 'V21', 'V22', 'V23', 'V24', 'V25', 'V26', 'V27', 'V28', 'Amount', 'Class'], dtype='object') Time float64 V1 float64 V2 float64 V3 float64 V4 float64 V5 float64 V6 float64 V7 float64 V8 float64 V9 float64 V10 float64 V11 float64 V12 float64 V13 float64 V14 float64 V15 float64 V16 float64 V17 float64 V18 float64 V19 float64 V20 float64 V21 float64 V22 float64 V23 float64 V24 float64 V25 float64 V26 float64 V27 float64 V28 float64 Amount float64 Class int64 dtype: objectdata.apply(lambda x: len(x.unique()))Time 124592 V1 275663 V2 275663 V3 275663 V4 275663 V5 275663 V6 275663 V7 275663 V8 275663 V9 275663 V10 275663 V11 275663 V12 275663 V13 275663 V14 275663 V15 275663 V16 275663 V17 275663 V18 275663 V19 275663 V20 275663 V21 275663 V22 275663 V23 275663 V24 275663 V25 275663 V26 275663 V27 275663 V28 275663 Amount 32767 Class 2 dtype: int64284807の取引データのうち、492が不正取引である。

data['Class'].sum()492また、今回は外れ値の処理は省略。

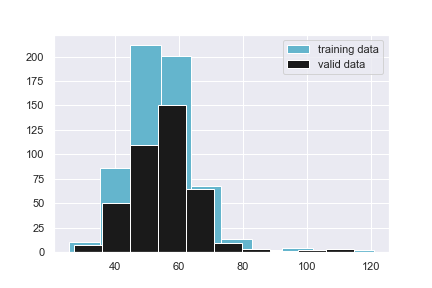

data.isnull().sum()Time 0 V1 0 V2 0 V3 0 V4 0 V5 0 V6 0 V7 0 V8 0 V9 0 V10 0 V11 0 V12 0 V13 0 V14 0 V15 0 V16 0 V17 0 V18 0 V19 0 V20 0 V21 0 V22 0 V23 0 V24 0 V25 0 V26 0 V27 0 V28 0 Amount 0 Class 0 dtype: int64データセットの分割

features_to_scale = data_X.drop(['Time'], axis=1).columns scaler = pp.StandardScaler(copy=True) data_X.loc[:, features_to_scale] = scaler.fit_transform(data_X[features_to_scale]) X_train, X_test, y_train, y_test = train_test_split(data_X, data_y, stratify=data_y)k分割交差検証

k_fold = StratifiedKFold(n_splits=5, shuffle=True, random_state=2018)2. ロジスティック回帰

log_reg = LogisticRegression() model = log_reg training_scores = [] cv_scores = [] predictions_based_on_k_folds = pd.DataFrame(data=[], index=y_train.index, columns=[0,1]) for train_index, cv_index in k_fold.split(np.zeros(len(X_train)), y_train.ravel()): X_train_fold, X_cv_fold = X_train.iloc[train_index,:], X_train.iloc[cv_index,:] y_train_fold, y_cv_fold = y_train.iloc[train_index], y_train.iloc[cv_index] model.fit(X_train_fold, y_train_fold) log_loss_training = log_loss(y_train_fold, model.predict_proba(X_train_fold)[:,1]) training_scores.append(log_loss_training) predictions_based_on_k_folds.loc[X_cv_fold.index,:] = model.predict_proba(X_cv_fold) log_loss_cv = log_loss(y_cv_fold, predictions_based_on_k_folds.loc[X_cv_fold.index,1]) cv_scores.append(log_loss_cv) print('Training Log Loss: ', log_loss_training) print('CV Log Loss: ', log_loss_cv) log_loss_logistic_regression = log_loss(y_train, predictions_based_on_k_folds.loc[:,1]) print('Logistic Regression Log Loss: ', log_loss_logistic_regression)Training Log Loss: 0.005995557191448456 CV Log Loss: 0.005125568292973096 Training Log Loss: 0.006253549879846522 CV Log Loss: 0.00484099351605527 Training Log Loss: 0.005099537613560319 CV Log Loss: 0.007849849024852518 Training Log Loss: 0.006164376210898366 CV Log Loss: 0.004896801432022977 Training Log Loss: 0.005689191528946416 CV Log Loss: 0.0072969772559491235 Logistic Regression Log Loss: 0.006002037904370599適合率・再現率曲線

preds = pd.concat([y_train, predictions_based_on_k_folds.loc[:,1]], axis=1) preds.columns = ['true_label', 'prediction'] predictions_based_on_k_folds_logistic_regression = preds.copy() precision, recall, thresholds = precision_recall_curve(preds['true_label'], preds['prediction']) average_precision = average_precision_score(preds['true_label'], preds['prediction']) plt.step(recall, precision, color='k', alpha=0.7, where='post') plt.fill_between(recall, precision, step='post', alpha=0.3, color='k') plt.xlabel('Recall') plt.ylabel('Precision') plt.xlim([0.0, 1.0]) plt.ylim([0.0, 1.05]) plt.title('Precision-Recall curve: Average Precision = {0:0.2f}'.format(average_precision))auROC (受信者動作特性曲線下面積)

fqr, tqr, thresholds = roc_curve(preds['true_label'], preds['prediction']) area_under_ROC = auc(fqr, tqr) plt.figure() plt.plot(fqr, tqr, color='r', lw=2, label='ROC curve') plt.plot([0, 1], [0, 1], color='k', lw=2, linestyle='--') plt.xlim([0.0, 1.0]) plt.ylim([0.0, 1.05]) plt.xlabel('False Positive Rate') plt.ylabel('True Positive Rate') plt.title('Receiver Operating Characteristic: Area under the Curve = {0:0.2f}'.format(area_under_ROC)) plt.legend(loc="lower right") plt.show()3. Random Forest

RFC = RandomForestClassifier(n_estimators=10, class_weight='balanced') model = RFC training_scores = [] cv_scores = [] predictions_based_on_k_folds = pd.DataFrame(data=[], index=y_train.index, columns=[0,1]) for train_index, cv_index in k_fold.split(np.zeros(len(X_train)), y_train.ravel()): X_train_fold, X_cv_fold = X_train.iloc[train_index,:], X_train.iloc[cv_index,:] y_train_fold, y_cv_fold = y_train.iloc[train_index], y_train.iloc[cv_index] model.fit(X_train_fold, y_train_fold) log_loss_training = log_loss(y_train_fold, model.predict_proba(X_train_fold)[:,1]) training_scores.append(log_loss_training) predictions_based_on_k_folds.loc[X_cv_fold.index,:] = model.predict_proba(X_cv_fold) log_loss_cv = log_loss(y_cv_fold, predictions_based_on_k_folds.loc[X_cv_fold.index,1]) cv_scores.append(log_loss_cv) print('Training Log Loss: ', log_loss_training) print('CV Log Loss: ', log_loss_cv) log_loss_random_forest = log_loss(y_train, predictions_based_on_k_folds.loc[:,1]) print('Random Forest Log Loss: ', log_loss_random_forest) preds = pd.concat([y_train, predictions_based_on_k_folds.loc[:,1]], axis=1) preds.columns = ['true_label', 'prediction'] predictions_based_on_k_folds_random_forests = preds.copy() precision, recall, thresholds = precision_recall_curve(preds['true_label'], preds['prediction']) average_precision = average_precision_score(preds['true_label'], preds['prediction']) plt.step(recall, precision, color='k', alpha=0.7, where='post') plt.fill_between(recall, precision, step='post', alpha=0.3, color='k') plt.xlabel('Recall') plt.ylabel('Precision') plt.xlim([0.0, 1.0]) plt.ylim([0.0, 1.05]) plt.title('Precision-Recall curve: Average Precision = {0:0.2f}'.format(average_precision)) preds = pd.concat([y_train, predictions_based_on_k_folds.loc[:,1]], axis=1) preds.columns = ['true_label', 'prediction'] predictions_based_on_k_folds_random_forests = preds.copy() precision, recall, thresholds = precision_recall_curve(preds['true_label'], preds['prediction']) average_precision = average_precision_score(preds['true_label'], preds['prediction']) plt.step(recall, precision, color='k', alpha=0.7, where='post') plt.fill_between(recall, precision, step='post', alpha=0.3, color='k') plt.xlabel('Recall') plt.ylabel('Precision') plt.xlim([0.0, 1.0]) plt.ylim([0.0, 1.05]) plt.title('Precision-Recall curve: Average Precision = {0:0.2f}'.format(average_precision))Training Log Loss: 0.00036571581908744426 CV Log Loss: 0.013690949627129164 Training Log Loss: 0.0004235723689615818 CV Log Loss: 0.00570945955148682 Training Log Loss: 0.00037000075061198505 CV Log Loss: 0.012404725764776376 Training Log Loss: 0.00039448357820150154 CV Log Loss: 0.009696866082135918 Training Log Loss: 0.00039912406259827595 CV Log Loss: 0.008095821155055213 Random Forest Log Loss: 0.0099195644361166974. XGBoost

params_xGB = { 'objective':'binary:logistic', 'eval_metric':'logloss' } training_scores = [] cv_scores = [] predictions_based_on_k_folds = pd.DataFrame(data=[], index=y_train.index, columns=['prediction']) for train_index, cv_index in k_fold.split(np.zeros(len(X_train)), y_train.ravel()): X_train_fold, X_cv_fold = X_train.iloc[train_index,:], X_train.iloc[cv_index,:] y_train_fold, y_cv_fold = y_train.iloc[train_index], y_train.iloc[cv_index] dtrain = xgb.DMatrix(data=X_train_fold, label=y_train_fold) dCV = xgb.DMatrix(data=X_cv_fold) bst = xgb.cv(params_xGB, dtrain, num_boost_round=2000, nfold=5, early_stopping_rounds=200, verbose_eval=50) best_rounds = np.argmin(bst['test-logloss-mean']) bst = xgb.train(params_xGB, dtrain, best_rounds) log_loss_training = log_loss(y_train_fold, bst.predict(dtrain)) training_scores.append(log_loss_training) predictions_based_on_k_folds.loc[X_cv_fold.index,'prediction'] = bst.predict(dCV) log_loss_cv = log_loss(y_cv_fold, predictions_based_on_k_folds.loc[X_cv_fold.index, 'prediction']) cv_scores.append(log_loss_cv) print('Training Log Loss: ', log_loss_training) print('CV Log Loss: ', log_loss_cv) log_loss_xgboost_gradient_boosting = log_loss(y_train, predictions_based_on_k_folds.loc[:,'prediction']) print('XGBoost Gradient Boosting Log Loss: ', log_loss_xgboost_gradient_boosting) params_xGB = { 'objective':'binary:logistic', 'eval_metric':'logloss' } training_scores = [] cv_scores = [] predictions_based_on_k_folds = pd.DataFrame(data=[], index=y_train.index, columns=['prediction']) for train_index, cv_index in k_fold.split(np.zeros(len(X_train)), y_train.ravel()): X_train_fold, X_cv_fold = X_train.iloc[train_index,:], X_train.iloc[cv_index,:] y_train_fold, y_cv_fold = y_train.iloc[train_index], y_train.iloc[cv_index] dtrain = xgb.DMatrix(data=X_train_fold, label=y_train_fold) dCV = xgb.DMatrix(data=X_cv_fold) bst = xgb.cv(params_xGB, dtrain, num_boost_round=2000, nfold=5, early_stopping_rounds=200, verbose_eval=50) best_rounds = np.argmin(bst['test-logloss-mean']) bst = xgb.train(params_xGB, dtrain, best_rounds) log_loss_training = log_loss(y_train_fold, bst.predict(dtrain)) training_scores.append(log_loss_training) predictions_based_on_k_folds.loc[X_cv_fold.index,'prediction'] = bst.predict(dCV) log_loss_cv = log_loss(y_cv_fold, predictions_based_on_k_folds.loc[X_cv_fold.index, 'prediction']) cv_scores.append(log_loss_cv) print('Training Log Loss: ', log_loss_training) print('CV Log Loss: ', log_loss_cv) log_loss_xgboost_gradient_boosting = log_loss(y_train, predictions_based_on_k_folds.loc[:,'prediction']) print('XGBoost Gradient Boosting Log Loss: ', log_loss_xgboost_gradient_boosting) fqr, tqr, thresholds = roc_curve(preds['true_label'], preds['prediction']) area_under_ROC = auc(fqr, tqr) plt.figure() plt.plot(fqr, tqr, color='r', lw=2, label='ROC curve') plt.plot([0, 1], [0, 1], color='k', lw=2, linestyle='--') plt.xlim([0.0, 1.0]) plt.ylim([0.0, 1.05]) plt.xlabel('False Positive Rate') plt.ylabel('True Positive Rate') plt.title('Receiver Operating Characteristic: Area under the Curve = {0:0.2f}'.format(area_under_ROC)) plt.legend(loc="lower right") plt.show()[0] train-logloss:0.43780+0.00001 test-logloss:0.43797+0.00002 [50] train-logloss:0.00012+0.00000 test-logloss:0.00260+0.00027 [100] train-logloss:0.00005+0.00000 test-logloss:0.00279+0.00026 [150] train-logloss:0.00004+0.00000 test-logloss:0.00288+0.00026 [200] train-logloss:0.00003+0.00000 test-logloss:0.00292+0.00027 Training Log Loss: 0.000792206342624254 CV Log Loss: 0.0029518170688098444 [0] train-logloss:0.43784+0.00002 test-logloss:0.43805+0.00007 [50] train-logloss:0.00013+0.00000 test-logloss:0.00292+0.00084 [100] train-logloss:0.00005+0.00000 test-logloss:0.00319+0.00095 [150] train-logloss:0.00004+0.00000 test-logloss:0.00328+0.00098 [200] train-logloss:0.00003+0.00000 test-logloss:0.00332+0.00099 Training Log Loss: 0.0005385763160533223 CV Log Loss: 0.001907025524733791 [0] train-logloss:0.43780+0.00002 test-logloss:0.43798+0.00009 [50] train-logloss:0.00011+0.00001 test-logloss:0.00278+0.00088 [100] train-logloss:0.00005+0.00000 test-logloss:0.00299+0.00097 [150] train-logloss:0.00004+0.00000 test-logloss:0.00308+0.00102 [200] train-logloss:0.00003+0.00000 test-logloss:0.00314+0.00104 Training Log Loss: 0.0008465584373083585 CV Log Loss: 0.003197665909513871 [0] train-logloss:0.43785+0.00004 test-logloss:0.43802+0.00006 [50] train-logloss:0.00012+0.00001 test-logloss:0.00293+0.00057 [100] train-logloss:0.00005+0.00000 test-logloss:0.00320+0.00063 [150] train-logloss:0.00004+0.00000 test-logloss:0.00329+0.00065 [200] train-logloss:0.00003+0.00000 test-logloss:0.00335+0.00067 Training Log Loss: 0.0005723772843934578 CV Log Loss: 0.001984392100999932 [0] train-logloss:0.43786+0.00003 test-logloss:0.43803+0.00006 [50] train-logloss:0.00013+0.00001 test-logloss:0.00290+0.00095 [100] train-logloss:0.00005+0.00000 test-logloss:0.00310+0.00104 [150] train-logloss:0.00004+0.00000 test-logloss:0.00316+0.00107 [200] train-logloss:0.00003+0.00000 test-logloss:0.00320+0.00108 Training Log Loss: 0.000810889205186624 CV Log Loss: 0.002501448645341887 XGBoost Gradient Boosting Log Loss: 0.0025084698498798665. LightGBM

params_lightGBM = { 'objective':'binary', 'metric':'binary_logloss', 'max_depth':4, 'learning_rate':0.01 } training_scores = [] cv_scores = [] predictions_based_on_k_folds = pd.DataFrame(data=[], index=y_train.index, columns=['prediction']) for train_index, cv_index in k_fold.split(np.zeros(len(X_train)), y_train.ravel()): X_train_fold, X_cv_fold = X_train.iloc[train_index,:], X_train.iloc[cv_index,:] y_train_fold, y_cv_fold = y_train.iloc[train_index], y_train.iloc[cv_index] lgb_train = lgb.Dataset(X_train_fold, y_train_fold) lgb_eval = lgb.Dataset(X_cv_fold, y_cv_fold, reference=lgb_train) gbm = lgb.train(params_lightGBM, lgb_train, num_boost_round=2000, valid_sets=lgb_eval, early_stopping_rounds=200) log_loss_training = log_loss(y_train_fold, gbm.predict(X_train_fold, num_iteration=gbm.best_iteration)) training_scores.append(log_loss_training) predictions_based_on_k_folds.loc[X_cv_fold.index,'prediction'] = gbm.predict(X_cv_fold, num_iteration=gbm.best_iteration) log_loss_cv = log_loss(y_cv_fold, predictions_based_on_k_folds.loc[X_cv_fold.index,'prediction']) cv_scores.append(log_loss_cv) print('Training Log Loss: ', log_loss_training) print('CV Log Loss: ', log_loss_cv) log_loss_lightgbm_gradient_boosting = log_loss(y_train, predictions_based_on_k_folds.loc[:,'prediction']) print('lightGBM Gradient Boosting Log Loss: ', log_loss_lightgbm_gradient_boosting) params_lightGBM = { 'objective':'binary', 'metric':'binary_logloss', 'max_depth':4, 'learning_rate':0.01 } training_scores = [] cv_scores = [] predictions_based_on_k_folds = pd.DataFrame(data=[], index=y_train.index, columns=['prediction']) for train_index, cv_index in k_fold.split(np.zeros(len(X_train)), y_train.ravel()): X_train_fold, X_cv_fold = X_train.iloc[train_index,:], X_train.iloc[cv_index,:] y_train_fold, y_cv_fold = y_train.iloc[train_index], y_train.iloc[cv_index] lgb_train = lgb.Dataset(X_train_fold, y_train_fold) lgb_eval = lgb.Dataset(X_cv_fold, y_cv_fold, reference=lgb_train) gbm = lgb.train(params_lightGBM, lgb_train, num_boost_round=2000, valid_sets=lgb_eval, early_stopping_rounds=200) log_loss_training = log_loss(y_train_fold, gbm.predict(X_train_fold, num_iteration=gbm.best_iteration)) training_scores.append(log_loss_training) predictions_based_on_k_folds.loc[X_cv_fold.index,'prediction'] = gbm.predict(X_cv_fold, num_iteration=gbm.best_iteration) log_loss_cv = log_loss(y_cv_fold, predictions_based_on_k_folds.loc[X_cv_fold.index,'prediction']) cv_scores.append(log_loss_cv) print('Training Log Loss: ', log_loss_training) print('CV Log Loss: ', log_loss_cv) log_loss_lightgbm_gradient_boosting = log_loss(y_train, predictions_based_on_k_folds.loc[:,'prediction']) print('lightGBM Gradient Boosting Log Loss: ', log_loss_lightgbm_gradient_boosting) fqr, tqr, thresholds = roc_curve(preds['true_label'], preds['prediction']) area_under_ROC = auc(fqr, tqr) plt.figure() plt.plot(fqr, tqr, color='r', lw=2, label='ROC curve') plt.plot([0, 1], [0, 1], color='k', lw=2, linestyle='--') plt.xlim([0.0, 1.0]) plt.ylim([0.0, 1.05]) plt.xlabel('False Positive Rate') plt.ylabel('True Positive Rate') plt.title('Receiver Operating Characteristic: Area under the Curve = {0:0.2f}'.format(area_under_ROC)) plt.legend(loc="lower right") plt.show()6. スタッキング

predictions_test_set_logistic_regression = pd.DataFrame(data=[], index=y_test.index, columns=['prediction']) predictions_test_set_logistic_regression.loc[:, 'prediction'] = log_reg.predict_proba(X_test)[:,1] log_loss_test_set_logistic_regression = log_loss(y_test, predictions_test_set_logistic_regression) predictions_test_set_random_forests = pd.DataFrame(data=[], index=y_test.index, columns=['prediction']) predictions_test_set_random_forests.loc[:, 'prediction'] = RFC.predict_proba(X_test)[:,1] log_loss_test_set_random_forests = log_loss(y_test, predictions_test_set_random_forests) predictions_test_set_xgboost_gradient_boosting = pd.DataFrame(data=[], index=y_test.index, columns=['prediction']) dtest=xgb.DMatrix(data=X_test) predictions_test_set_xgboost_gradient_boosting.loc[:, 'prediction'] = bst.predict(dtest) log_loss_test_set_xgboost_gradient_boosting = log_loss(y_test, predictions_test_set_xgboost_gradient_boosting) predictions_test_set_light_gbm_gradient_boosting = pd.DataFrame(data=[], index=y_test.index, columns=['prediction']) predictions_test_set_light_gbm_gradient_boosting.loc[:, 'prediction'] = gbm.predict(X_test, num_iteration=gbm.best_iteration) log_loss_test_set_light_gbm_gradient_boosting = log_loss(y_test, predictions_test_set_light_gbm_gradient_boosting) print('Log Loss of Logistic Regression on Test Set: ', log_loss_test_set_logistic_regression) print('Log Loss of Random Forests on Test Set: ', log_loss_test_set_random_forests) print('Log Loss of XGBoost Gradient Boosting on Test Set: ', log_loss_test_set_xgboost_gradient_boosting) print('Log Loss of LightGBM Gradient Boosting on Test Set: ', log_loss_test_set_light_gbm_gradient_boosting)Log Loss of Logistic Regression on Test Set: 0.006119615555779465 Log Loss of Random Forests on Test Set: 0.012553984393960552 Log Loss of XGBoost Gradient Boosting on Test Set: 0.003148207871388518 Log Loss of LightGBM Gradient Boosting on Test Set: 0.00333516364607809prediction_based_on_kfolds_four_models = pd.DataFrame(data=[], index=y_train.index) prediction_based_on_kfolds_four_models = prediction_based_on_kfolds_four_models.join(predictions_based_on_k_folds_logistic_regression['prediction'].astype(float), how='left').join(predictions_based_on_k_folds_random_forests['prediction'].astype(float), how='left', rsuffix="2").join(predictions_based_on_k_folds_xgboost_gradient_boosting['prediction'].astype(float), how='left', rsuffix="3").join(predictions_based_on_k_folds_light_gbm_gradient_boosting['prediction'].astype(float), how='left', rsuffix="4") prediction_based_on_kfolds_four_models.columns = ['predsLR', 'predsRF', 'predsXGB', 'predsLightGBM'] X_train_with_predictions = X_train.merge(prediction_based_on_kfolds_four_models, left_index=True, right_index=True)7. で、もう一回LightGBM

params_lightGBM = { 'objective':'binary', 'metric':'binary_logloss', 'max_depth':4, 'learning_rate':0.01 } training_scores = [] cv_scores = [] predictions_based_on_k_folds = pd.DataFrame(data=[], index=y_train.index, columns=['prediction']) for train_index, cv_index in k_fold.split(np.zeros(len(X_train)), y_train.ravel()): X_train_fold, X_cv_fold = X_train_with_predictions.iloc[train_index, :], X_train_with_predictions.iloc[cv_index, :] y_train_fold, y_cv_fold = y_train.iloc[train_index], y_train.iloc[cv_index] lgb_train = lgb.Dataset(X_train_fold, y_train_fold) lgb_eval = lgb.Dataset(X_cv_fold, y_cv_fold, reference=lgb_train) gbm = lgb.train(params_lightGBM, lgb_train, num_boost_round=2000, valid_sets=lgb_eval, early_stopping_rounds=200) log_loss_training = log_loss(y_train_fold, gbm.predict(X_train_fold, num_iteration=gbm.best_iteration)) training_scores.append(log_loss_training) predictions_based_on_k_folds.loc[X_cv_fold.index,'prediction'] = gbm.predict(X_cv_fold, num_iteration=gbm.best_iteration) log_loss_cv = log_loss(y_cv_fold, predictions_based_on_k_folds.loc[X_cv_fold.index,'prediction']) cv_scores.append(log_loss_cv) print('Training Log Loss: ', log_loss_training) print('CV Log Loss: ', log_loss_cv) log_loss_ensemble = log_loss(y_train, predictions_based_on_k_folds.loc[:,'prediction']) print('lightGBM Gradient Boosting Log Loss: ', log_loss_ensemble) preds = pd.concat([y_train, predictions_based_on_k_folds.loc[:,'prediction']], axis=1) preds.columns = ['true_label', 'prediction'] predictions_based_on_k_folds_ensamble = preds.copy() precision, recall, thresholds = precision_recall_curve(preds['true_label'], preds['prediction']) average_precision = average_precision_score(preds['true_label'], preds['prediction']) plt.step(recall, precision, color='k', alpha=0.7, where='post') plt.fill_between(recall, precision, step='post', alpha=0.3, color='k') plt.xlabel('Recall') plt.ylabel('Precision') plt.xlim([0.0, 1.0]) plt.ylim([0.0, 1.05]) plt.title('Precision-Recall curve: Average Precision = {0:0.2f}'.format(average_precision)) preds = pd.concat([y_train, predictions_based_on_k_folds.loc[:,'prediction']], axis=1) preds.columns = ['true_label', 'prediction'] predictions_based_on_k_folds_ensamble = preds.copy() precision, recall, thresholds = precision_recall_curve(preds['true_label'], preds['prediction']) average_precision = average_precision_score(preds['true_label'], preds['prediction']) plt.step(recall, precision, color='k', alpha=0.7, where='post') plt.fill_between(recall, precision, step='post', alpha=0.3, color='k') plt.xlabel('Recall') plt.ylabel('Precision') plt.xlim([0.0, 1.0]) plt.ylim([0.0, 1.05]) plt.title('Precision-Recall curve: Average Precision = {0:0.2f}'.format(average_precision))8. 実運用システムパイプライン

new_data = pd.read_cv('') new_feature_to_scale = new_data.drop(['Time'], axis=1).columns new_data.loc[:, new_feature_to_scale] = sX.fit_transform(new_data[new_feature_to_scale]) gbm.predict(new_data, num_iteration=gbm.best_iteration)

- 投稿日:2020-10-12T20:41:07+09:00

PythonでTwitterのツイートをしてみたいけどハマった話

自動でTwitterのツイートをしてみたいという話を聞いて、ちょっと作ってみたがハマった話

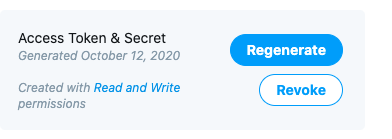

CONSUMER_KEYがない

色々なサイトを見て検索するとpythonからツイートをするにあたって必要な項目が4項目あります。

CONSUMER_KEY, CONSUMER_SECRET,

ACCESS_TOKEN, ACCESS_SECRETが必要と出てくるのですがどう見てもCONSUMER_KEYとCONSUMER_SECRETがない!

ただ、どうやっても見つからないので検索すると

CONSUMER_KEYはAPI KEYで

CONSUMER_SECRETはAPI_key_secretでいいそうです。検索すればよく見るコードですが下記のコードに変数を変更しました。

このほうが理解しやすいと思います。twitter.pyimport json from requests_oauthlib import OAuth1Session #ここにKeyとToken API_KEY = 'XXXXXXX' API_KEY_SECRET = 'XXXXXXX' ACCESS_TOKEN = 'XXXXXXX' ACCESS_TOKEN_SECRET = 'XXXXXXX' twitter = OAuth1Session(API_KEY, API_KEY_SECRET, ACCESS_TOKEN, ACCESS_TOKEN_SECRET) url = "https://api.twitter.com/1.1/statuses/update.json" print(twitter) tweet = "Pythonからのテストツイートです\r改行する\r\n改行\n改行" # ツイート内容 params = {"status" : tweet} req = twitter.post(url, params = params) #ここでツイート if req.status_code == 200: #成功 print("Succeed!") else: #エラー print("ERROR : %d"% req.status_code)401エラーでツイートができない

API_KEYを取ったあと上記コードで実行を行っても

ERROR : 401

で全然ツイートができない。このケースは設定漏れでした。401の通り、権限なしでした。

まず、最初の設定は読み込みのみなので書き込みもできるように設定を変更しました。

ただ、401エラーは継続です。

なんで出来なかったか。

多分ですがあとは読み込み & 書き込み設定に変更したあとに

再度ACCESS_KEYを取り直すこと(regenerate)。再度取得しないと読み込みしか出来ないACCESS_KEYを使用している状態で書き込みができないのだと思われます。

それでも401エラーダメな場合は何度か取得して変数に代入してみてください。

参考資料

- 投稿日:2020-10-12T20:35:53+09:00

Natural Language : GPT - Japanese Generative Pretraining Transformer

目標

Microsoft Cognitive Toolkit (CNTK) を用いて GPT をやってみました。

訓練に使用する日本語のコーパスを用意しておきます。

NVIDIA GPU CUDA がインストールされていることを前提としています。導入

今回は日本語のコーパスを用意して日本語文生成モデルを訓練しました。単語の分割に関しては、sentencepiece [1] を用いたサブワードモデルを作成しておきます。

GPT

Generative Pretraining Transformer (GPT) [2] は Transformer [3] の Decoder 部分だけを使用します。Transformer については Natural Language : Machine Translation Part2 - Neural Machine Translation Transformer で紹介しています。

また今回は Natural Language : BERT Part2 - Unsupervised pretraining ALBERT のときと同様に、Pre-Layer Normalization Transformer [4] で構成しました。層構造の詳細を下図に示します。

また、Factorized embedding parameterization と Cross-layer parameter sharing を用いてモデルを軽量化しました。

GPT の Multi-Head Attention では Masked Self-Attention を使用しており、自己回帰による教師なし学習を行います。

訓練における諸設定

各パラメータの初期値は分散 0.02 の正規分布に設定しました。

損失関数は Cross Entropy Error を使用します。

最適化アルゴリズムには Adam [5] を採用しました。Adam のハイパーパラメータ $β_1$ は 0.9、$β_2$ は CNTK のデフォルト値に設定しました。

学習率は、Cyclical Learning Rate (CLR) [6] を使って、最大学習率は 1e-4、ベース学習率は 1e-8、ステップサイズはエポック数の 10倍、方策は triangular2 に設定しました。

モデルの訓練はミニバッチ学習によって 1,000,000 Iteration を実行しました。

実装

実行環境

ハードウェア

・CPU Intel(R) Core(TM) i7-5820K 3.30GHz

・GPU NVIDIA Quadro RTX 6000 24GBソフトウェア

・Windows 10 Pro 1909

・CUDA 10.0

・cuDNN 7.6

・Python 3.6.6

・cntk-gpu 2.7

・cntkx 0.1.53

・pandas 1.1.2

・sentencenpiece 0.1.91実行するプログラム

訓練用のプログラムは GitHub で公開しています。

jgpt_training.py解説

今回の実装で要となる内容について補足します。

OpenAI GPT

GPT は自然言語処理における事前学習モデルとして提案されました。時刻 $t$ までの入力単語 $w_1, w_2, ..., w_{t}$ からその次の時刻 $t+1$ の単語 $w_{t+1}$ を予測する自己回帰言語モデルです。

p(w) = \prod^T_{t=1} p(w_{t+1} | w_1, w_2, ..., w_t)GPT は BERT と同様に教師なし事前学習をしてから複数のタスクのデータセットでファインチューニングをします。BERT では特別な [MASK] トークンを用いることで教師なし学習を実現していましたが、GPT では下図のように自己回帰を用いることで教師なし事前学習を行います。

下図は BERT と GPT の Multi-Head Attention を表しています。BERT では過去・未来の双方向の情報を使用できますが、GPT では未来の情報がマスクされるため単方向の情報のみを使用します。

GPT-2

GPT-2 [7] では Pre-Layer Normalization で構成され、Transformer Decoder は最大 48層で 15億のパラメータを持ちます。

GPT-2 は WebText と呼ばれる 800万の文章を含む 40GB の巨大なデータセットを使用して事前学習を行うことで、Zero-shot でも複数のタスクで高い性能を示しました。

GPT-3

GPT-3 [8] は GPT-2 のネットワークとデータセットの規模を限界まで巨大にすることで、さらに高精度の言語モデルを獲得しました。

GPT-3 のモデルは GPT-2 と同じ構成になっていますが、Transformer Decoder に Sparse Transformer [9] を導入しており、最大 96層で 175兆のパラメータを持ちます。GPT-3 の学習には約 4億9000万円のコストがかかっているらしく、仮に 1台の GPU で訓練を行った場合は約 355年かかるとのことです。

GPT-3 は人間との文章のやり取りに違和感のないレベルの文章を生成することができるとされていますが、双方向情報を必要とするようなタスクでは BERT系モデルよりも性能が劣るという弱点は顕在のようです。

結果

Training Loss

訓練時の損失関数のログを可視化したものが下図です。横軸は繰り返し回数、縦軸は損失関数の値を表しています。

日本語文生成の例

訓練したモデルによる生成の例を示します。> から始める単語を入力として、その続きを生成します。

>人類は 人類は、この再建されたバイオエンジニアリング子宮を学習した経験のを、経済学の初めてデバイスをデバイスを学習し、その対価を切り替えない。 >魔法が 魔法が、その大きな成功を収める人だ。 >地球 地球は、後者の重要性が強調される。 >葵葉月は、 葵葉月は、その安らかなぶるな、身をかがめた。日本語っぽい文が生成できているように見えますが、意味不明な文章になってしまっています。違和感のないレベルの文章を生成するにはより巨大なモデルと訓練データセット、それを実行できるだけのハードウェアが必要だと実感できます。

参考

Natural Language : Machine Translation Part2 - Neural Machine Translation Transformer

Natural Language : BERT Part2 - Unsupervised pretraining ALBERT

- Taku Kudo and John Richardson. "SentencePiece: A simple and language independent subword tokenizer and detokenizer for Neural Text Processing", arXiv preprint arXiv:1808.06226, (2018).

- Alec Radford, Karthik Narasimhan, Tim Salimans, and Ilya Sutskever. "Improving Language Understanding by Generative Pre-Training", (2018): 12.

- Ashish Vaswani, et. al. "Attention Is All You Need", Advances in neural information processing systems. 2017. p. 5998-6008.

- Ruibin Xiong, Yunchang Yang, Di He, Kai Zheng, Shuxin Zheng, Chen Xing, Huishuai Zhang, Yanyan Lan, Liwei Wang, and Tie-Yan Liu . "On Layer Normalization in the Transformer Architecture", arXiv preprint arXiv:2002.04745 (2020).

- Diederik P. Kingma and Jimmy Lei Ba. "Adam: A method for stochastic optimization", arXiv preprint arXiv:1412.6980 (2014).

- Leslie N. Smith. "Cyclical Learning Rates for Training Neural Networks", 2017 IEEE Winter Conference on Applications of Computer Vision. 2017, p. 464-472.

- Alex Radford, Jeffrey Wu, Rewon Child, David Luan, Dario Amodei, and Ilya Sutskever. "Language Models are Unsupervised Multitask Learners", OpenAI blog 1.8 (2019): 9.

- Tom B. Brown, et al. "Language Models are Few-Shot Learners", arXiv preprint arXiv:2005.14165 (2020).

- Rewon Child, Scott Gray, Alec Radford, and Ilya Sutckever. "Generating Long Sequences with Sparse Transformers", arXiv preprint arXiv:1904.10509 (2019).

- 投稿日:2020-10-12T20:02:31+09:00

Pythonに疲れたのでnehanでデータ分析してみた(コロナ禍でもライブに行きたい - 後編)

ご挨拶

こんにちは、マンボウです。

「Twtter×コロナ」引き続き分析していきます。

前編はtweetテキストを形態素解析し、頻出単語の日別出現数を出すところまでやりました。Twitterのデータから、上昇・下降トレンドの単語を探してみる

コロナウイルスが社会問題になってから半年以上が経過しました。

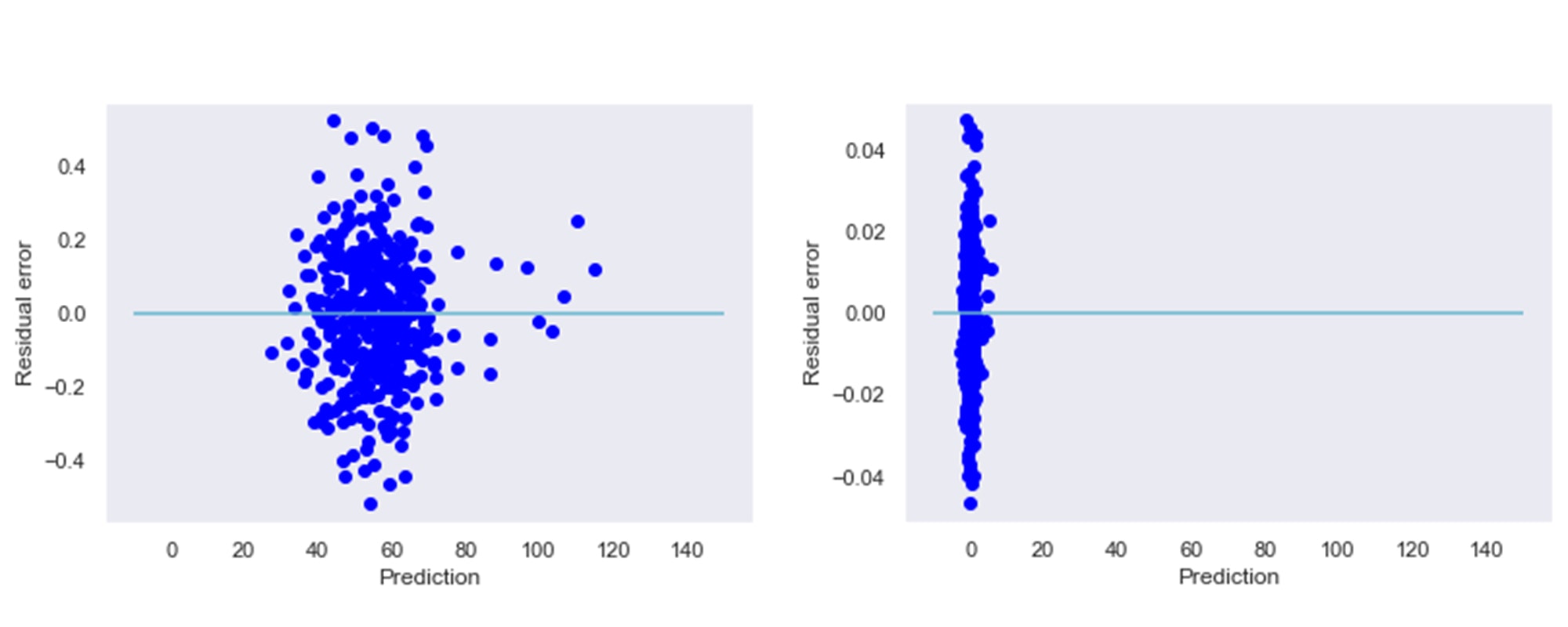

人々の中で何が高まり、逆に何が忘れられているのか、つぶやきから追ってみます。

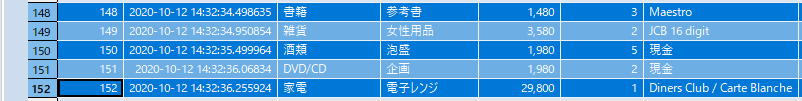

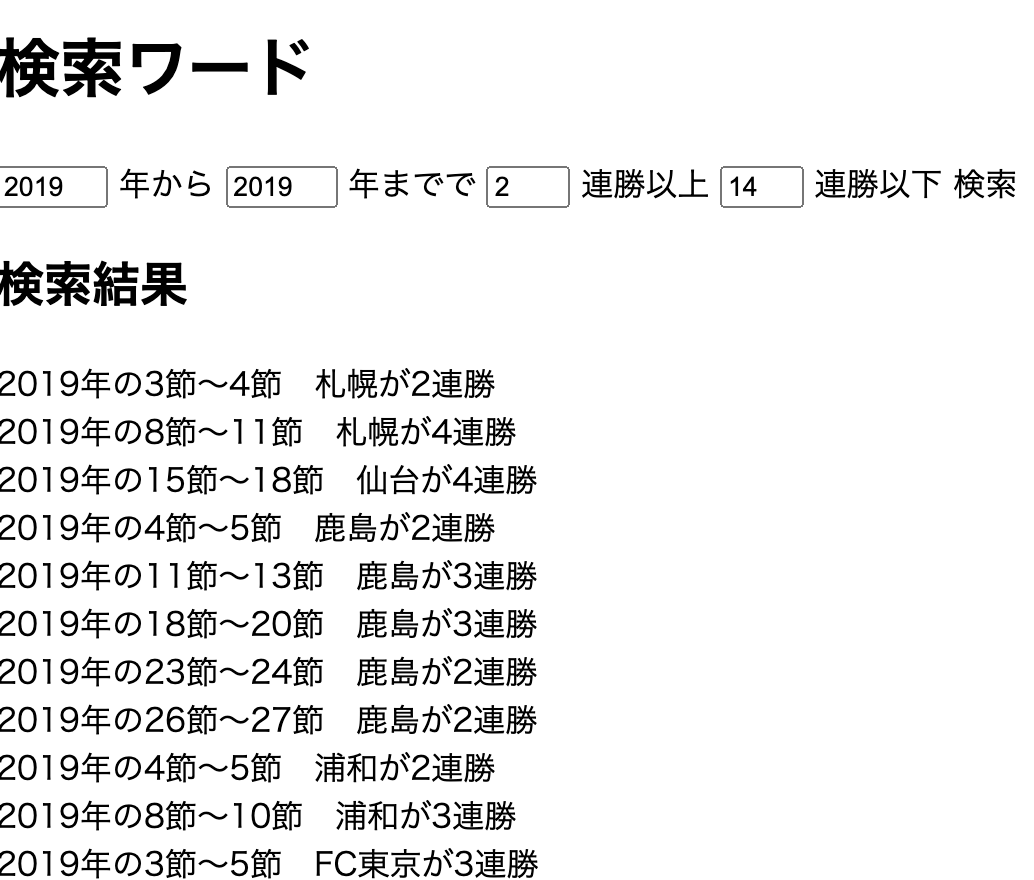

後編では、回帰分析を用いて上昇・下降トレンドの単語を見つけ出します。データ

前編で作成した、日別・単語別出現数のデータを使います。

↓データ

↓可視化すると

回帰分析を行う準備

日が経過するに連れ、出現数が増or減、の単語を見つけたいと思います。

つまりy:特定単語のtweet数=a\times x:経過日数+bこういう回帰式を導き、傾きである

aと、相関係数を観察してみよう、と。

データ操作としては、日付のデータから「経過日数」を算出する必要があります。

アプローチとして、連番を・単語ごとに・日付が若い順から、振ります。from scipy.spatial.distance import cdist import pandas as pd import statsmodels.api as sm port_23 = port_22.copy() model_params = {'method': 'first', 'ascending': True} port_23[['Created_At']] = pd.to_datetime(port_23[['Created_At']]) port_23['index'] = port_23.groupby(['単語'])[['Created_At']].rank(**model_params) port_23[['Created_At']] = port_23[['Created_At']].map(lambda x: x.date())回帰分析を実施。単語ごとに

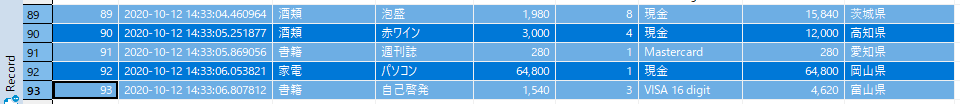

選定した24単語が経過日数に応じてどう変化しているか、回帰分析結果から観察していきます。

pythonで書こうとすると、単語ごとにループを回したりと、大変です。group_keys = ['単語'] X_columns = ['index'] Y_column = 'カウント' groups = port_23.groupby(group_keys) models = {} summaries = {} def corr_xy(X, y): """目的変数と説明変数の相関係数を求める""" X_label = X.columns.tolist() X = X.T.values y = y.values.reshape(1, -1) corr = 1 - cdist(X, y, metric='correlation') corr = pd.DataFrame(corr, columns=['目的変数との相関係数']) corr['説明変数'] = X_label return corr for i, g in groups: X = g[X_columns] Y = g[Y_column].squeeze() corr = corr_xy(X, Y) try: model = sm.OLS(y, sm.add_constant(X, has_constant='add')).fit() model.X = X.columns models[i] = model summary = pd.DataFrame( { '説明変数': X.columns, '係数': np.round(model.params, 5), '標準偏差': np.round(model.bse, 5), 't値': np.round(model.tvalues, 5), 'Pr(>|t|)': np.round(model.pvalues, 5) }, columns=['説明変数', '係数', '標準偏差', 't値', 'Pr(>|t|)']) summary = summary.merge(corr, on='説明変数', how='left') summaries[i] = summary except: continue res = [] for key, value in summaries.items(): value[group_keys] = key res.append(value) concat_summary = pd.concat(res, ignore_index=True) port_24 = models port_25 = concat_summary↓nehanであれば、

グループごとにモデルを作成するオプションで面倒なループ処理を書かずに済みます。

そして、単語ごとの回帰分析の結果を得られました。

説明変数=const、は切片の情報です。

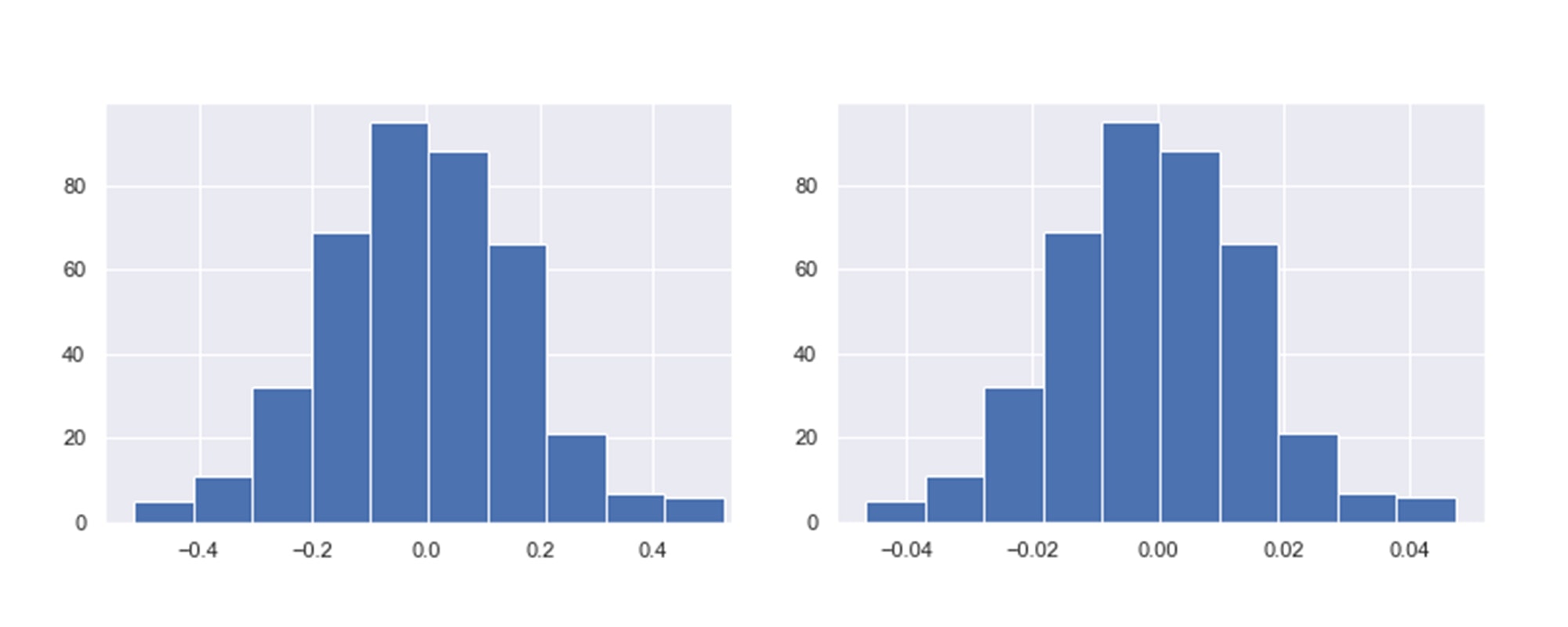

上昇/下降トレンドの単語に絞る

様々な解釈はありますが、ここでは

- 相関係数が0.4以上

- 相関係数が-0.4以下

に絞り、これを相関がある、として単語を抽出します。

port_27 = port_25[(port_25['目的変数との相関係数'] <= -0.4) | (port_25['目的変数との相関係数'] >= 0.4)]結果を観察

上昇トレンドの単語

- イベント

- ライブ

下降トレンドの単語

- 患者

- 政府

- 症状

- 重症

まとめ

コロナの脅威は去ったわけでは有りませんが、危機的な時期にニュースでよく見ていたような単語の出現数は減り、イベントやライブといった、自粛の影響を強く受けた単語の出現数が増えている様子が見て取れます。

もちろん、これだけでは「みんなライブに行きたいんだ!」とは言えませんが、ここまでのデータを見た、いち考察として本テーマを締めさせていただければと思います。前処理したデータから様々な分析、可視化に繋げられるプログラミング不要の分析ツールnehanの魅力が少しでも伝われば幸いです。

※分析ツールnehanのご紹介はこちらから。

※↓今日の内容

なお、上記のソースコードはnehanのpythonエクスポート機能で出力したコードをコピペしました。(一部バグってたので、書き直しました・・・)

- 投稿日:2020-10-12T19:33:53+09:00

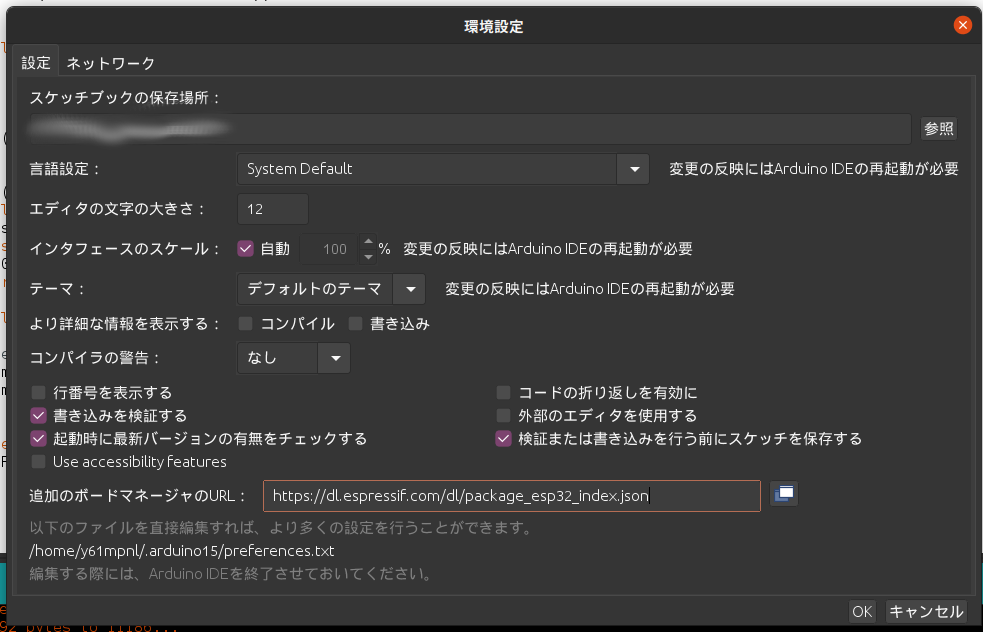

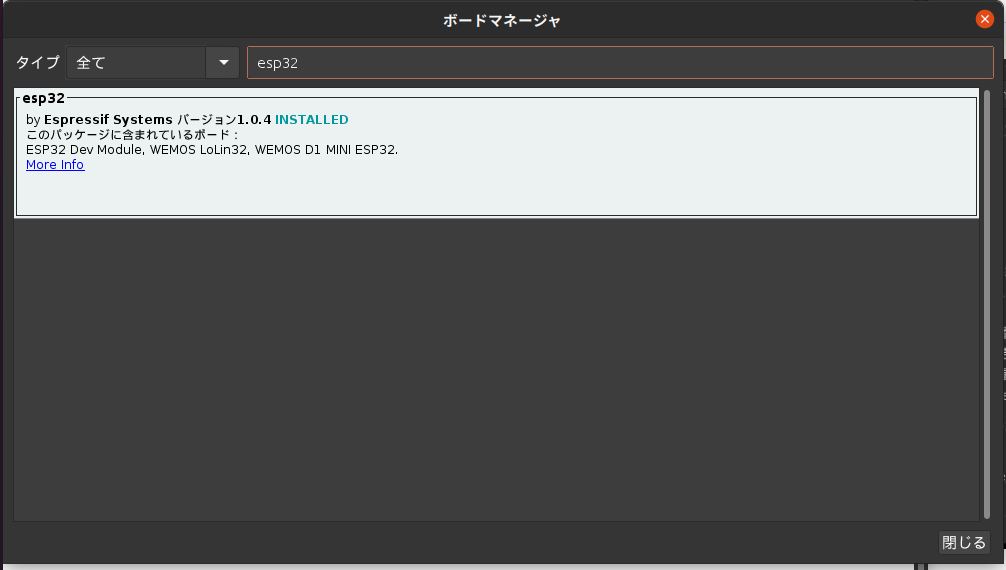

ESP32 を Arduino IDE から操作する

ESP32 用の環境構築

ESP32用のプログラムを書けるようにする

まずはここからArduino IDEをダウンロード

Arduino IDE の初期設定は省略上のバーの

ファイル > 環境設定から追加のボードマネージャーのURLにhttps://dl.espressif.com/dl/package_esp32_index.jsonを追加する。すでに入力がある場合;で区切ってつなげる。

ツール > ボード > ボードマネージャーから右上のテキストボックスにesp32と入力して検索

esp32 by Espressif Systemsを選択してインストール

以降、Arduino IDE を開いて

ツール > ボードを見てみると確かにESP32 Arduinoの枠が追加されている。使い方・文法など

なんと使い方は普段と同様である。特に設定を変更する必要はない。arduino のプログラムを書くときと全く同じように書き、コンパイルし、書き込めばいい。

謎のエラー

最後にボードへの書き込みの際に自分がハマったポイントを書き記しておく

ボードへ書き込もうとするとexec: "python": executable file not found in $PATHといったエラーが出て書き込めなくなることがある。普通に読むとpythonがインストールされていない、あるいはpythonのPATHが通っていない、ということだが自分の環境は確実に整っている。

しかしよく読むと"python"が無いと言っているのであって"python3"あるいは"python2"が無いとは言っていないのである。もしやと思いsudo apt install python-is-python3をしてみた。これで"python"が存在することになった(中身は"python3"だが)。これで書き込んでみると無事完了 しっかり動作した。よくわからない設定ですね。

- 投稿日:2020-10-12T19:13:53+09:00

Pythonの内包表記が好きなのでmapと比較検証してみた

はじめに

こんにちは、麻菜結です。Pythonの内包表記が数多あるプログラミング言語の記法の中でも多機能かつ可読性が高く素晴らしい文法なのは間違いありませんが(個人の意見であり多大に偏見を含んでいる可能性があります)、よく競技プログラミングでは以下の記法が見られます。

l = list(map(int, input().split()))内包表記の敵、

mapですね(偏見を(略)。いちいちlistかまさないといけないmapがなんぼのもんじゃい!ということで速度を比較してみました。環境

wsl1のUbuntuを使います。

$ uname -a Linux LAPTOP-H6KC5C7N 4.4.0-18362-Microsoft #1049-Microsoft Thu Aug 14 12:01:00 PST 2020 x86_64 x86_64 x86_64 GNU/Linux $ py --version Python 3.8.0概要

110000行5列の非負な整数値が並ぶテキストファイルを用意する。先頭に10000と記述しファイルの列の数とする。

2timeモジュールのtime()を用いて始まりの時間を記録する。

3行ごとに内包表記かmapでデータを格納する。

4data.appendを繰り返して終わったらtime()で時間を取得して2の値と差分を出しそれを実行時間として表示する。

55回ほど試しそれの平均を取り比較する。スクリプト

以下のスクリプトを用います。

内包表記import time start = time.time() n = int(input()) data = [] for _ in range(n): data.append([int(e) for e in input().split(" ")]) process_time = time.time() - start print(process_time)mapimport time start = time.time() n = int(input()) data = [] for _ in range(n): data.append(list(map(int, input().split()))) process_time = time.time() - start print(process_time)検証

五回ぐらい実行してみてその平均を考えてみます。

まずは内包表記です。まぁまずまずですね。内包表記$ for((i=0;i<5;i++)); do cat InputText.txt | py time_comp.py; done 0.0833895206451416 0.07289266586303711 0.08693099021911621 0.12533855438232422 0.09039974212646484平均すると0.09541くらいでしょうか。

次にmapです。map$ for((i=0;i<5;i++)); do cat InputText.txt | py time_map.py; done 0.0980367660522461 0.08674144744873047 0.11994338035583496 0.08462047576904297 0.08770060539245605こちらも平均すると0.09541と同じですね。

(いや有意差が無いぞ…内包表記遅いやないかい!で記事書こうと思ったのに)追加検証

ラズパイ4でやりました。

$ uname -a Linux asana 5.4.51-v8+ #1333 SMP PREEMPT Mon Aug 10 16:58:35 BST 2020 aarch64GNU/Linux $ py --version Python 3.7.3 $ for((i=0;i<5;i++)); do cat InputText.txt | py time_comp.py; done 0.12080025672912598 0.10874629020690918 0.1127462387084961 0.1103978157043457 0.15588116645812988 $ for((i=0;i<5;i++)); do cat InputText.txt | py time_map.py; done 0.11949372291564941 0.11281895637512207 0.11392450332641602 0.2708289623260498 0.276080846786499平均を計算すると、内包表記は0.1217、mapは0.1786ぐらいでしょうか。ここでは内包表記が優位になりました。

Windowsでやりました。

> cmd /c ver Microsoft Windows [Version 10.0.18363.1110] > py --version Python 3.8.2 > for($i = 0;$i -le 5; $i++){cat .\InputText.txt | py .\time_comp.py} 1.0488629341125488 0.7845804691314697 1.163966178894043 0.7295846939086914 0.7399096488952637 0.8466687202453613 > for($i = 0;$i -le 5; $i++){cat .\InputText.txt | py .\time_map.py} 0.5758388042449951 0.5823671817779541 0.6683478355407715 0.6919825077056885 0.6597652435302734 0.6140100955963135

Windowsおっそ明らかな有意差が出ましたね、結構OSによる差があるみたいです。結論

結論としては、『環境や状況に左右されやすく、どっちが良いとは断言できない。』という感じでしょうか。自分はmapの方が明らかに早いからよくつかわれていているのだと思い込んでいましたが、そういうわけでは無いみたいですね。それともまた他のアーキテクチャやOSでは差が出るのか…inputをsys.stdinにしたら変わるのか、そもそもリストアペンドが遅くて差が隠れてしまっているのではないか、メモリの効率はいかがなのかなど他にも検証事項はありそうですが、この辺でいったん終わりにしたいと思います。

ここまでお読みいただいてありがとうございました。皆さんはどちら派ですか?

- 投稿日:2020-10-12T18:50:05+09:00

Django シフト表 自分の所属している施設のみを表示する

スタッフ全員で20名を超えるのでシフト表が自分の関係ない施設分まで表示されていると見にくくなるので、修正しました。