- 投稿日:2020-05-21T23:24:57+09:00

データサイエンティストへの道

はじめに

私は、 首都圏の理系大学に通う大学4年生です。

ありがたいことに早いうちに機械学習系のエンジニア職の内定をいただけました。

大学の研究室では、プログラミング言語のPythonを軸に機械学習を勉強しています。

でも、covitショックで大学の研究室にはいけなくなり、独自に勉強せねばならぬ...!

しかも、自分の実力が会社に入ってから通用するのか?勉強しなきゃ...!!!

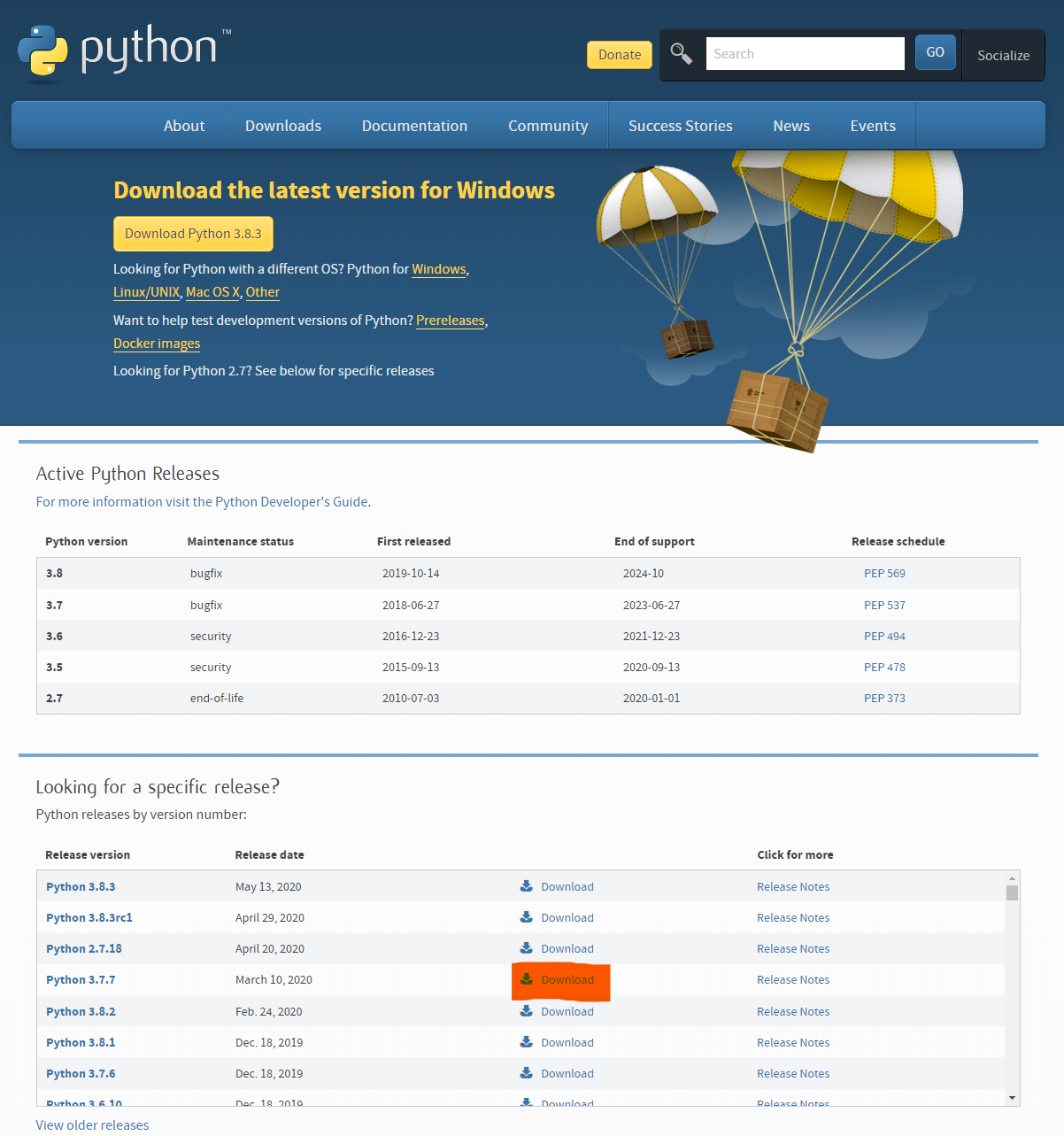

となった僕が、今まで独学で勉強してきた物を紹介&リストアップStep1 : Pythonを理解しようぜ

機械学習やAIを勉強していくに当たって、Pythonの基本的な文法がわからんぞってなると行き詰まってしまいました。

そのため、僕が使ったPythonの勉強サイトは、こいつらです。Python以外の言語を勉強するのにも使える!EntryNo.1 : Progate

言わずと知れた、プログラミング学習サイト。

スライドと環境構築不要のエディター付きの学習サイトになっている。

解説がスライドなので、音楽を聴きながら勉強することができるのが個人的なGoodポイント。

とくにGoodなのは、後述するPaizaラーニングにもあるが、環境構築不要のエディターがあることが、初心者に優しい。

こいつだけで、結構な基礎を勉強することができる。

実際に他の言語とかも勉強することもできるし、まじで便利。おすすめ度:★★★☆☆

URL : https://prog-8.com/EntryNo.2 : Paizaラーニング

Paizaラーニングは、動画と環境構築不要のエディター付きの学習サイト。

前述のProgateと違うのが、スライドではなく動画であること。

しっかりと動画で、動いているところが見れるからしっかりと自分で手を動かしながらコードを構築することができるのがGood。また、Paizaの運営会社「paiza株式会社」は、HR(人材系)の事業をやっていることから、自分が勉強したプログラミング知識で就職活動をすることができるのがとてもよかった。

(自分もここで就職を決めることができた。)動画で基礎を勉強することができ、職にまでつなげることができるところがとてもよかった。

学習教材の内容も独自の内容なので、飽きずにやることができる。

progate同様こいつだけで、結構な基礎を勉強することができる。

実際に他の言語とかも勉強することもできるし、まじで便利。おすすめ度:★★★★☆

URL : https://paiza.jp/worksEntryNo.3 : ドットインストール

ドットインストールは、動画のみの学習サイト。

前述した二つのサイトに比べ、環境構築が必要な点がネックになっているからあまり使わなかった。ただ、強みとして前述した二つのサイトに比べて、カバーしている領域の広さがとても広い。

マイナーながら統計学をやっていれば一度は目にする「R」の講座があったり、「VBA」や「GAS」、「Docker」などの知ってたら地味に便利になる物の学習ができたり、最近では前述した二つにも増えてきたが、「AWS」の講座があったりとほんとに幅が広い。おすすめ度:★★☆☆☆

URL : https://dotinstall.com/

Step1まとめ

ここまで紹介してきたサイトのPythonの基礎を勉強することができれば、この後に記載する学習サイトでも特に苦労せずに以降できると思います。

全部やらずとも、一つだけ自分に合うと思うサイトを使えばいいと思います。

何をやれば良いかわからない人は、個人的にPaizaを使えば良いのではないかなと思っています。

就職にも繋がるって良くない?笑Step 2 機械学習・AIってなんだ?

Pythonの基礎がわかったところで、ここから機械学習について勉強をしました。

ここら辺から、僕はサイト以外にも本などを使って勉強をし始めました。EntryNo.1 : キカガク

キャッチコピーが

最先端を、最短距離で身につける。初学者から始められる学習サイト

基礎的なところから、しっかり勉強することができるサイト。

機械学習初心者から、中級者に上がるまでをサポートしてくれるようなサイト。大きく分けて、「自然言語」「画像処理」「ディープラーニング」 などの基礎的なところを無料で勉強することができるサイト。

tensorflowやpytorchのどちらかで勉強するコースが整っているが、基本的に自分の環境が整っている人向けという印象。

ただ、環境構築についてもチュートリアルで説明があるので、敷居は低め!

Google ColaboratoryというGoogle様が提供しているとても素晴らしいエディターでも一応勉強することはできる。おすすめ度:★★★★☆

URL : https://www.kikagaku.ai/EntryNo.2 : AI academy

ゴール別にカリキュラムを設定してくれるので、便利。

「AWS」「GCP」や「R」などの機械学習を扱う上で便利なその他ツールの解説などがドキュメント形式である便利なサイト。

Pythonの基本的な文法から立ち戻って勉強することができるが、基礎を勉強するならStep1のサイトの方がわかりやすかったなとか思ったり。

「画像認識」「動画認識」などの分野を勉強することができ、学べる幅が広い。ただ、深いところまで勉強するには、課金しなければいけないのだが、月額1000円ほどで勉強ができるので結構良いのではとか思って私は課金してます。環境構築についてもこのサイトにチュートリアルがあるので、しっかり自分のPCに環境を作ることもできる!

おすすめ度:★★★★☆

URL : https://aiacademy.jp/EntryNo.3 : aidemy

僕はまだあまり使いこなしていないが、AI・機械学習を勉強することができるサイト。

コース別に技能を習得することができるみたい。

あまり使ってないので、コメントは程々にしておきます。おすすめ度 : 未知数

URL : https://aidemy.net/書籍編

書籍で購入したいという方もたくさんいると思います。

僕が購入している書物をいくつか紹介します。

Python実践データ分析100本ノック

結構しっかりと勉強することができる。

データの配布もあり、分析をJupyterで行うことができるのがポイント高め。前処理大全

どちらかというとStep3であると便利な本。

辞書的な運用がメインになるけど、あると便利。Kaggleで勝つデータ分析の技術

Step3で紹介しているKaggleで使えるスキルについて書いてある本。

この本が出版されたときにKaggle上で日本のKagglerのスコアが異常に伸び、日本のKagglerが不正を疑われたとか噂がある本。

機械学習を志すなら、持っておいて損ないと思う一冊。AI白書

いるかいらないかでいうと微妙だけど、AI市場の動向はわかる。番外編

中学数学からはじめるAI(人工知能)のための数学入門

Youtuberの予備校のノリで学ぶ「大学の数学・物理」(通称:ヨビノリ)が、Aidemyとコラボした動画。

AIや機械学習のうらで動いている数学を解説してくれている動画になっており、しばらく数学とはご無沙汰だなと感じているそこのあなた!是非見てみると良いですよ!ヨビノリさんのYouTubeチャンネルはこちら

他の動画でも数学などを取り扱っているので、是非見てみてください。

言語処理100本ノック

言語処理にフォーカスをした物

東北大学の乾・岡崎研究室(当時)(現在は乾・鈴木研究室)の新人研修の一つであるプログラミング基礎勉強会で使われてきた物。Qiita上に答えのようなものが、いくつかあるので自分で勉強していくこともできると思います。

URL : https://nlp100.github.io/ja/

importについて詳しく知りたい...

まにゃpy@Python解説の猫さんのツイートのなかにあった良く分かるimportの話。

今まで、呪文のように唱えていたimportやfrom 〇〇 import ××についてシックリくる形で解説されています。Pythonのパッケージやモジュールをimportする方法は

— まにゃpy@Python解説の猫 (@uuyr112) May 18, 2020

import モジュール名

from パッケージ名 import モジュール名

import パッケージ名.モジュール名

from モジュール名 imoport 関数名

import モジュール名 as 〇〇

などがあります。これらの違いを詳しく解説しました。https://t.co/qgqaKs27t9URL : https://twitter.com/uuyr112/status/1262259224903421952?s=20

Step3 : 実際に分析してみよう!

ここまできたあなたは、きっと自分が成し遂げたいことを実現する能力を身につけていると思います。

ここから先の分析の勉強をするにあたって、方法としては大きく分けて、2つあると思います。

- コンペに参加する。

- 自分でデータを集める。 ## コンペへの参加 敷居が低いものとしては、コンペに参加することをあげることができます。 コンペとして有名なのは、

- Kaggle

- Quevico AI Competitions

- Signate

などがあると思います。

Kaggle

世界中のデータサイエンティストがしのぎを削るコンペ

最先端のアルゴリズムなどを使っている人もいるため、Kernelというコードを読んでいるだけでもとてもとても勉強になる。

ただ、データサイエンスの領域になると文化的側面やコンペ対象に深い知識がないと難しい。

そういった面で、外国発のコンペということもあって、難しいように感じる。Step2までとは違って、ほんとに難しい。

これをやるといきなり100点を目指さずに、不完全でも良いからアウトプットをしていくことの大切さを知る。

Kaggleチュートリアルは、いろんな方が出しているので、それをやっていくことで力を伸ばせるのでは?と思っています。みなさんお馴染みのメルカリについてのコンペもあり、ここから僕は入りました。

メルカリチュートリアル他に有名ところだとタイタニック号などもありますので、様々なチュートリアルを経てコンペにチャレンジしてみると良いかもしれないです。

Quevico AI Competitions

最近できたコンペ。

Instagramの広告で出てきた。コンペ数が少ないが、しっかりとstep2で勉強したことが生かせそうなコンペになってる。

言語が日本語なのも、嬉しいポイントSignate

日本発のデータサイエンスコンペ。

言語が日本語で、コビットチャレンジなどもあって、日本のデータサイエンスの中心地になればなと思っている。

人のkarnelが見れないのが少し残念自分でデータを集める。

自分でデータを集めるとなったら、やれることは無限大です。

ただ、追加で取得しなければいけない技術として、スクレイピングの技術が必要になります。スクレイピングは、様々なサイトで勉強できますが、AI academyである程度勉強できるので、一度こちらで勉強してみるのも良いかもしれないです。

個人的に使っているデータ収集の方法

Twitter developer

Twitter APIを取得することができる開発者アカウントの申請をすることができる。

意外とできることが多くて、可能性がすごく大きい。オープンソースのデータセットが手に入るサイト

自分でいつか使おうと思ってストックしているサイトです。

FineReportさんが公開しているデータ分析に必要なオープンデータ20選から抜粋したものです。

番外編

市場調査系レポート

変数選択などのアイディアを得ることができそうなレポートを提供してくれるサイト。

自分でいつか使おうと思ってストックです。博報堂生活総合研究所

博報堂が、収集したデータがレポート形式で、アップロードされているサイト。

マクロミル

市場調査事例や分析事例がレポート形式でみることができるサイト

DODA

就職状況のレポートをみることができる。

最後に

今まで勉強したサイトなどをリスト化しました。

これで、慌てて記憶の底からなんだったけなーと思わなくてすみそうです。笑

COVITショックがあり、GWあたりから無料で学べるツールサイトが多くなってきて、とても勉強のやりがいがある一方で、自分が目指している業界の競争率が高くなりそうで、焦っています。今後は動画解析などの技術を身につけて、TikTokの分析とかしてみたいなと思っています。

TikTokのAPIがあるみたいなので、チャレンジしたいと思っています。最後にここまで長い間読んでくださった方ありがとうございます。

参考文献

紹介サイトまとめ

- Progate様

- Paizaラーニング様

- ドットインストール様

- キカガク様

- AI academy様

- aidemy様

- Youtuberの予備校のノリで学ぶ「大学の数学・物理」様

- 乾・鈴木研究室様

- Kaggle様

- Quevico AI Competitions様

- Signate様

- まにゃpy@Python解説の猫様

- FineReport様

- Twitter developer様

- 日本本統計局様

- YouTubeデータセット様

- Google Trend Search様

- 博報堂生活総合研究所様

- マクロミル様

- DODA様

良質なコンテンツの提供ありがとうございます。

掲載してはいけない内容などありましたら、削除します。

- 投稿日:2020-05-21T22:19:12+09:00

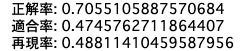

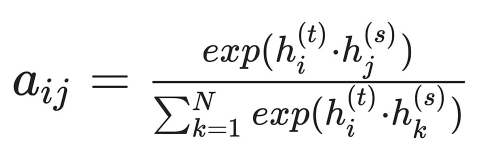

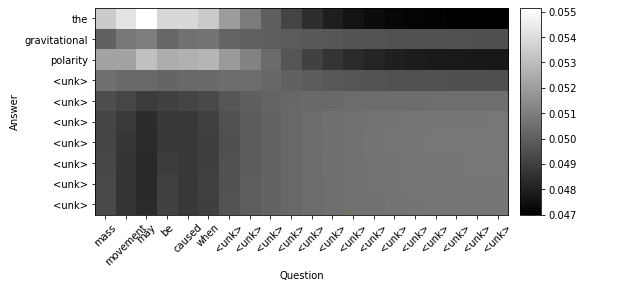

Python: 日本語テキスト:単語の類似性から発話の特徴

単語の類似性を知る

発話テキストの形態素解析

Python: 日本語テキスト:形態素解析では

「分析対象データの読み込み」と「自然言語処理の前処理の基本」を学びました。

この投稿ではでは、これまでに学んだ内容を活かして、分析対象である「発話データセットの加工の手法」を学びます。

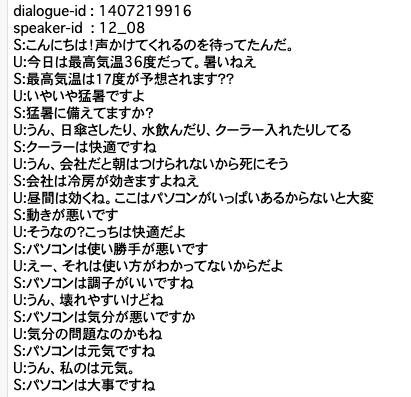

特に、単語の類似性に着目した前処理の実装を行います。今回のデータセットのフラグには

O破綻ではない発話

T破綻とは言い切れないが違和感のある発話

X明らかにおかしいと感じる発話、の3種類があります。ここでは、O破綻ではない発話 のフラグを元に処理していきます。

例題で出現する変数について

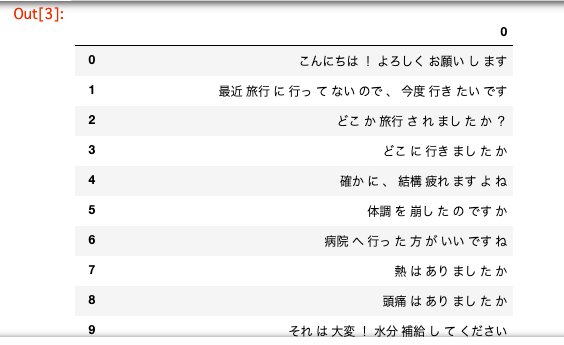

破綻ではない発話のみを抽出した変数df_label_text_Oの内容(49行目)

index と column が含まれるNumPy配列のndarrayです。0 1 1 O すみません、あなたは誰ですか? 24 O そうなんですか。高校野球がお好きなんですか? 48 O 甲子園でしょ? ... .. ... 2376 O そうですか。破綻ではない発話データセットを処理する際に用いる変数rowの内容(62行目)

rowは、tolist()を用いて

NumPy配列ndarrayのdf_label_text_OをPythonのリスト型に変換した値です。[['O', 'すみません、あなたは誰ですか?'], ['O', 'そうなんですか。高校野球がお好きなんですか?'], ['O', '甲子園でしょ?'], ... ['O', 'そうですか。']]例題はこちら

import os import json import pandas as pd import re from janome.tokenizer import Tokenizer # init100ディレクトリを指定 file_path = './6110_nlp_preprocessing_data/init100/' file_dir = os.listdir(file_path) # フラグと発話内容を格納する空のリストを作成 label_text = [] # JSONファイルを1ファイルずつ10ファイル分処理 for file in file_dir[:10]: # 読み込み専用モードで読み込み r = open(file_path + file, 'r', encoding='utf-8') json_data = json.load(r) # 発話データ配列`turns`から発話内容とフラグを抽出 for turn in json_data['turns']: turn_index = turn['turn-index'] # 発話ターンNo speaker = turn['speaker'] # 話者ID utterance = turn['utterance'] # 発話内容 # 先頭行はシステムの発話なので除外 if turn_index != 0: # 人の発話内容を抽出 if speaker == 'U': u_text = '' u_text = utterance else: a = '' for annotate in turn['annotations']: # 破綻かどうかのフラグを抽出 a = annotate['breakdown'] # フラグと人の発話内容をリストに格納 tmp1 = str(a) + '\t' + u_text tmp2 = tmp1.split('\t') label_text.append(tmp2) # リスト`label_text`をDataFrameに変換 df_label_text = pd.DataFrame(label_text) # 重複する行を削除 df_label_text = df_label_text.drop_duplicates() # 破綻ではない発話のみを抽出 df_label_text_O = df_label_text[df_label_text[0] == 'O'] t = Tokenizer() # 空の破綻ではない発話データセットを作成 morpO = [] # 分かち書きした単語を格納 tmp1 = [] tmp2 = '' # 1行ずつ読み込み # .values:indexやcolumnを除いて読み込み # .tolist:NumPy配列ndarrayをPythonのリスト型に変換 for row in df_label_text_O.values.tolist(): # 正規表現で数字とアルファベットの大文字・小文字を除去してください reg_row = re.sub('[0-9a-zA-Z]+', '', row[1]) reg_row = reg_row.replace('\n', '') # Janomeで形態素解析を行います for token in t.tokenize(reg_row): # 単語の表層系を`morpO`に追加してください tmp1.append(token.surface) tmp2 = ' '.join(tmp1) morpO.append(tmp2) tmp1 = [] # 形態素解析した単語を出力 pd.DataFrame(morpO)単語文書行列とは

自然言語データを解析するには、単語データ(文章データ)を数値データへ変換すればよいと説明しました。

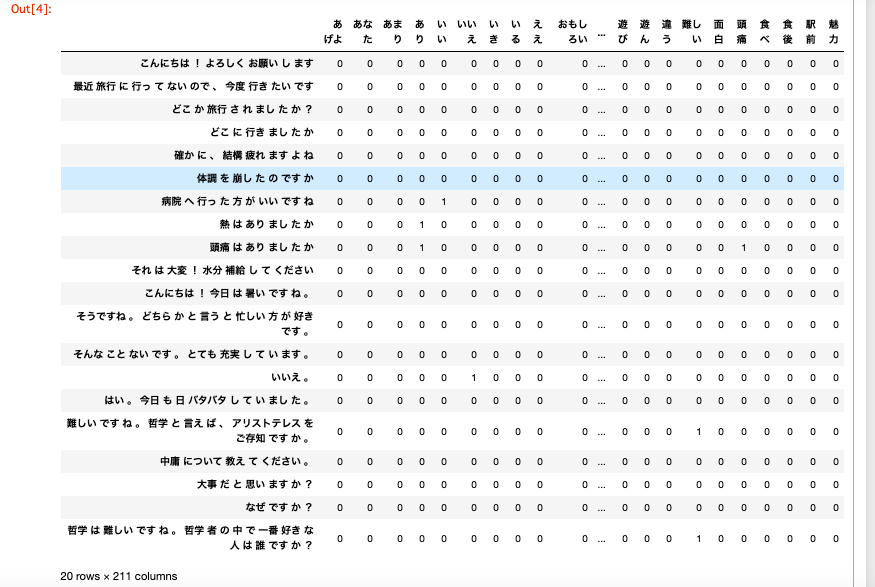

その変換の方法の一つに単語文書行列(term-document matrix)と呼ばれるものがあります。単語文書行列とは、文書に出現する単語の頻度 を表形式で表したものです。

各文書に含まれる単語データは形態素解析によって得ることができ

そこから各単語の出現数をカウントして数値データに変換しています。単語文書行列は、行方向に単語/列方向に文書、もしくはその逆の行方向に文書/列方向に

単語を並べた行列形式で表現されます。全N種類の単語と全M個の文書があるとき、N行×M列の単語文書行列と呼びます。

図の単語文書行列は、文書1には単語1が2回、単語2が1回、単語3が3回、・・・、単語Nが0回

出現することを表しています。単語の出現回数をカウントするには Python標準ライブラリのcollections.Counter()を用いるなど方法はいくつかありますが ここではscikit-learn(サイキット・ラーン)のCountVectorizer()を用いて 単語文書行列を作成する一例を示します。 CountVectorizer()はテキストを単語に分割し、単語の出現回数を数えます。from sklearn.feature_extraction.text import CountVectorizer # `CountVectorizer()`を用いた変換器を生成します CV = CountVectorizer() corpus = ['This is a pen.', 'That is a bot.',] # `fit_transform()`で`corpus`の学習と、単語の出現回数を配列に変換します X = CV.fit_transform(corpus) print(X) >>> 出力結果 (0, 2) 1 (0, 1) 1 (0, 4) 1 (1, 0) 1 (1, 3) 1 (1, 1) 1 # `get_feature_names()`で学習した単語が入っているリストを確認します print(CV.get_feature_names()) >>> 出力結果 ['bot', 'is', 'pen', 'that', 'this'] # カウントした出現回数を`toarray()`でベクトルに変換して表示します print(X.toarray()) >>> 出力結果 # 行:`corpus`で与えた文章の順 # 列:`get_feature_names()`で確認した単語の順 [[0 1 1 0 1] [1 1 0 1 0]]使用例はこちら

import os import json import pandas as pd import numpy as np import re from janome.tokenizer import Tokenizer from sklearn.feature_extraction.text import CountVectorizer # init100ディレクトリを指定 file_path = './6110_nlp_preprocessing_data/init100/' file_dir = os.listdir(file_path) # フラグと発話内容を格納する空のリストを作成 label_text = [] # JSONファイルを1ファイルずつ10ファイル分処理 for file in file_dir[:10]: r = open(file_path + file, 'r', encoding='utf-8') json_data = json.load(r) # 発話データ配列`turns`から発話内容とフラグを抽出 for turn in json_data['turns']: turn_index = turn['turn-index'] speaker = turn['speaker'] utterance = turn['utterance'] if turn_index != 0: if speaker == 'U': u_text = '' u_text = utterance else: a = '' for annotate in turn['annotations']: a = annotate['breakdown'] tmp1 = str(a) + '\t' + u_text tmp2 = tmp1.split('\t') label_text.append(tmp2) # リスト`label_text`をDataFrameに変換し、重複を削除 df_label_text = pd.DataFrame(label_text) df_label_text = df_label_text.drop_duplicates() # 破綻ではない発話のみを抽出 df_label_text_O = df_label_text[df_label_text[0] == 'O'] t = Tokenizer() # 空の破綻ではない発話データセットを作成 morpO = [] tmp1 = [] tmp2 = '' # 数字とアルファベットの大文字・小文字を除去 for row in df_label_text_O.values.tolist(): reg_row = re.sub('[0-9a-zA-Z]+', '', row[1]) reg_row = reg_row.replace('\n', '') # Janomeで形態素解析 for token in t.tokenize(reg_row): tmp1.append(token.surface) tmp2 = ' '.join(tmp1) morpO.append(tmp2) tmp1 = [] # リスト形式からNumPy配列へ変換(arrayのほうが計算速度が速いため) morpO_array = np.array(morpO) # 単語の出現回数をカウントしてください cntvecO = CountVectorizer() # 学習を行い、単語の出現回数を配列に変換してください morpO_cntvecs = cntvecO.fit_transform(morpO_array) # ndarray配列に変換 morpO_cntarray = morpO_cntvecs.toarray() # DataFrame形式で単語の出現回数を表示 # columns(列):分割した単語 # index(行):元の発話データ pd.DataFrame(morpO_cntarray, columns=cntvecO.get_feature_names(), index=morpO).head(20)1文字単語の注意

デフォルトでは1文字の単語はカウントされません。

日本語には1文字でも意味を持つ単語があるので、日本語を扱う場合には注意が必要です。

1文字の単語もカウントするにはCountVectorizer()にtoken_pattern='(?u)\b\w+\b'を指定します。CountVectorizer(token_pattern='(?u)\\b\\w+\\b')重みあり単語文書行列とは

単語の出現回数(頻度)を値として持つ単語文書行列では

どの文書においても普遍的に出現する単語(例えば「私」「です」など)の出現頻度が高くなる傾向があります。一方、特定の文書にのみ出現する単語の出現頻度が低くなり

単語から各文書を特徴付けることが難しくなります。

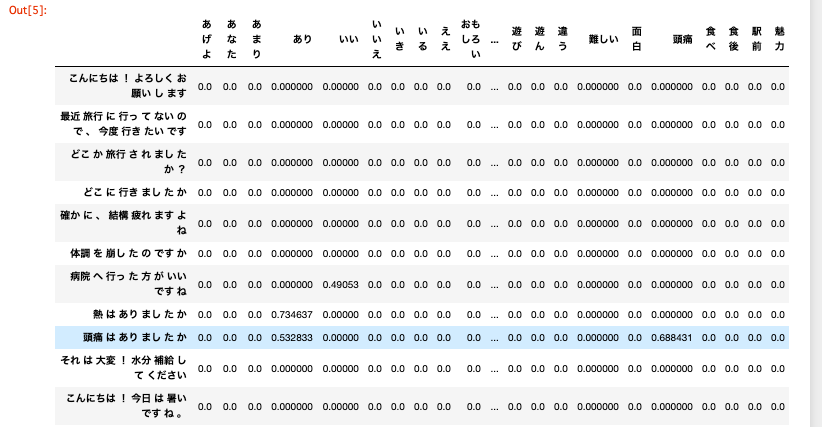

そのため、単語文書行列では単語の出現頻度 TF(Term Frequency)に 逆文書頻度 IDF(Inverse Document Frequency)を掛けた TF-IDF 値が多く利用されます。ある単語のIDF値は、log(総文書数/ある単語が出現する文書数)+ 1 で計算できます。

例えば、ある単語が全4文書中3文書に含まれていれば

IDF値は log(4/3)+1≒1.1 となり

特定の文書にのみ出現する単語ほどIDF値が大きくなります。IDF値が大きいということは、その単語の重要度が高く、その文書の特徴であると言えます。

TFからIDFを計算し、TFとIDFを掛けたTF-IDF値を算出することができます。

以下にTfidfVectorizer()を用いたTF-IDF値による重みあり単語文書行列を作成する一例を示します。

import numpy as np from sklearn.feature_extraction.text import TfidfVectorizer # 小数点以下を有効数字2桁で表示する np.set_printoptions(precision=2) docs = np.array([ "白 黒 赤", "白 白 黒", "赤 黒" ]) # `TfidfVectorizer()`を用いた変換器を生成します vectorizer = TfidfVectorizer(use_idf=True, token_pattern="(?u)\\b\\w+\\b") # `fit_transform()`で`docs`の学習と、重み付けされた単語の出現回数を配列に変換します vecs = vectorizer.fit_transform(docs) print(vecs.toarray()) # >> 出力結果 [[ 0.62 0.62 0.48] [ 0.93 0. 0.36] [ 0. 0.79 0.61]]①vectorizer = TfidfVectorizer()で ベクトル表現化(単語を数値化すること)を行う変換器を生成します。 ②use_idf=Falseにすると、tfのみの重み付けになります。 ③vectorizer.fit_transform()で、文書をベクトルに変換します。 引数には、空白文字によって分割された(分かち書きされた)配列を与えます。 ④toarray()によって出力をNumPyのndarray配列に変換します。np.set_printoptions()は、NumPy配列の表示のフォーマットを定める関数です。 print()で値を表示する際にのみ有効な設定で元の値は変わりません。 引数precision=には小数点以下の表示桁数を指定します。使用例はこちら

import os import json import pandas as pd import numpy as np import re from janome.tokenizer import Tokenizer from sklearn.feature_extraction.text import TfidfVectorizer # init100ディレクトリを指定 file_path = './6110_nlp_preprocessing_data/init100/' file_dir = os.listdir(file_path) # フラグと発話内容を格納する空のリストを作成 label_text = [] # JSONファイルを1ファイルずつ10ファイル分処理 for file in file_dir[:10]: r = open(file_path + file, 'r', encoding='utf-8') json_data = json.load(r) # 発話データ配列`turns`から発話内容とフラグを抽出 for turn in json_data['turns']: turn_index = turn['turn-index'] speaker = turn['speaker'] utterance = turn['utterance'] if turn_index != 0: if speaker == 'U': u_text = '' u_text = utterance else: a = '' for annotate in turn['annotations']: a = annotate['breakdown'] tmp1 = str(a) + '\t' + u_text tmp2 = tmp1.split('\t') label_text.append(tmp2) # リスト`label_text`をDataFrameに変換し、重複を削除 df_label_text = pd.DataFrame(label_text) df_label_text = df_label_text.drop_duplicates() # 破綻ではない発話のみを抽出 df_label_text_O = df_label_text[df_label_text[0] == 'O'] t = Tokenizer() # 空の破綻ではない発話データセットを作成 morpO = [] tmp1 = [] tmp2 = '' # 数字とアルファベットの大文字・小文字を除去 for row in df_label_text_O.values.tolist(): reg_row = re.sub('[0-9a-zA-Z]+', '', row[1]) reg_row = reg_row.replace('\n', '') # Janomeで形態素解析 for token in t.tokenize(reg_row): tmp1.append(token.surface) tmp2 = ' '.join(tmp1) morpO.append(tmp2) tmp1 = [] # リスト形式からNumPy配列へ変換(arrayのほうが計算速度が速いため) morpO_array = np.array(morpO) # ①ベクトル表現化を行う変換器を生成 tfidf_vecO = TfidfVectorizer(use_idf=True) # ②単語をベクトル表現に変換 morpO_tfidf_vecs = tfidf_vecO.fit_transform(morpO_array) # ③ndarray配列に変換 morpO_tfidf_array = morpO_tfidf_vecs.toarray() # DataFrame形式で単語(ベクトル表現)を表示してください pd.DataFrame(morpO_tfidf_array, columns=tfidf_vecO.get_feature_names(), index=morpO).head(20)単語の類似度(相関)を計算

特徴量 とは、そのデータが持つ他のデータとは異なる特徴です。CountVectorizer()で作成した単語文書行列では単語の出現回数を

TfidfVectorizer()で作成した単語文書行列では単語のTF-IDF値を単語の特徴量としています。例えば、画像に写っている物体が犬か猫かを見分ける時

まず無意識に耳の形に目がいくのではないでしょうか。この場合、耳(を含む領域)が特徴量と言えます。

文書分類の問題では、各単語を特徴量として使用し、教師あり学習モデルを作成します。ここでは上記とは異なる、2つの単語の出現の仕方がどの程度似ているか

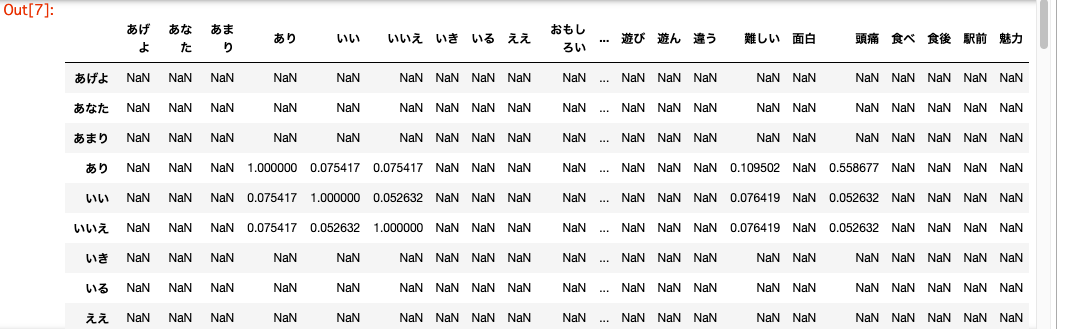

つまり類似度を特徴量とした、教師なし学習モデル を作成します。類似度を測る方法として身近なものは相関係数ですが

その他にベクトル同士の類似度を測る コサイン類似度や 集合同士の類似度を測る Jaccard係数 が有名です。ここでは、類似度を求めるのにpandas.DataFrameのcorr()メソッドを用い

各列間の相関係数を算出します。corr()メソッドはデータ型が数値型・ブール型の列が計算対象となり

文字列や欠損値NaNは除外されます。corr = DataFrame.corr()corr()の引数には相関係数の算出方法を以下より指定します。

'pearson':ピアソンの積率相関係数(デフォルト) 'kendall':ケンドールの順位相関係数 'spearman':スピアマンの順位相関係数使用例はこちら

import os import json import pandas as pd import numpy as np import re from janome.tokenizer import Tokenizer from sklearn.feature_extraction.text import TfidfVectorizer # init100ディレクトリを指定 file_path = './6110_nlp_preprocessing_data/init100/' file_dir = os.listdir(file_path) # フラグと発話内容を格納する空のリストを作成 label_text = [] # JSONファイルを1ファイルずつ10ファイル分処理 for file in file_dir[:10]: r = open(file_path + file, 'r', encoding='utf-8') json_data = json.load(r) # 発話データ配列`turns`から発話内容とフラグを抽出 for turn in json_data['turns']: turn_index = turn['turn-index'] speaker = turn['speaker'] utterance = turn['utterance'] if turn_index != 0: if speaker == 'U': u_text = '' u_text = utterance else: a = '' for annotate in turn['annotations']: a = annotate['breakdown'] tmp1 = str(a) + '\t' + u_text tmp2 = tmp1.split('\t') label_text.append(tmp2) # リスト`label_text`をDataFrameに変換し、重複を削除 df_label_text = pd.DataFrame(label_text) df_label_text = df_label_text.drop_duplicates() # 破綻ではない発話のみを抽出 df_label_text_O = df_label_text[df_label_text[0] == 'O'] t = Tokenizer() # 空の破綻ではない発話データセットを作成 morpO = [] tmp1 = [] tmp2 = '' # 数字とアルファベットの大文字・小文字を除去 for row in df_label_text_O.values.tolist(): reg_row = re.sub('[0-9a-zA-Z]+', '', row[1]) reg_row = reg_row.replace('\n', '') # Janomeで形態素解析 for token in t.tokenize(reg_row): tmp1.append(token.surface) tmp2 = ' '.join(tmp1) morpO.append(tmp2) tmp1 = [] # TF-IDF値による重みありの単語文書行列を作成 morpO_array = np.array(morpO) tfidf_vecO = TfidfVectorizer(use_idf=True) morpO_tfidf_vecs = tfidf_vecO.fit_transform(morpO_array) morpO_tfidf_array = morpO_tfidf_vecs.toarray() # 単語の出現回数をDataFrame形式に変換 dtmO = pd.DataFrame(morpO_tfidf_array, columns=tfidf_vecO.get_feature_names(), index=morpO).head(20) # 相関行列を作成 corr_matrixO = dtmO.corr().abs() # `.abs()` は絶対値を求めるメソッドです # 相関行列の表示 corr_matrixO単語の類似性から発話の特徴を知る

類似度リストの作成

ここからは、前節で作成した2つの単語の相関係数を特徴量としたネットワーク分析によって

定量的な分析を行っていきます。ネットワーク分析を行うために、相関係数を行列形式からリスト形式へ変換します。

行列形式をリスト形式に変換するには pandas.DataFrameのstack()メソッドを用います。from pandas import DataFrame # DataFrameを用意 df=DataFrame([[0.1,0.2,0.3],[0.4,'NaN',0.5]], columns=['test1','test2','test3'], index=['AA','BB']) print(df) # >>> 出力結果 test1 test2 test3 AA 0.1 0.2 0.3 BB 0.4 NaN 0.5 # stack : 列から行への変換 print(df.stack()) # >>> 出力結果 AA test1 0.1 test2 0.2 test3 0.3 BB test1 0.4 test2 NaN test3 0.5 # unstack : 行から列への変換 print(df.unstack()) # >>> 出力結果 test1 AA 0.1 BB 0.4 test2 AA 0.2 BB NaN test3 AA 0.3 BB 0.5使用例はこちら

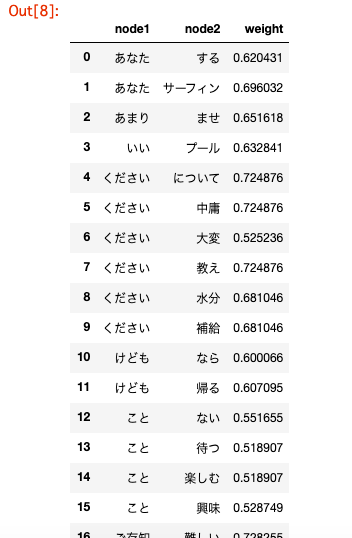

import os import json import pandas as pd import numpy as np import re from janome.tokenizer import Tokenizer from sklearn.feature_extraction.text import TfidfVectorizer # init100ディレクトリを指定 file_path = './6110_nlp_preprocessing_data/init100/' file_dir = os.listdir(file_path) # フラグと発話内容を抽出したリストを作成 label_text = [] for file in file_dir[:10]: r = open(file_path + file, 'r', encoding='utf-8') json_data = json.load(r) for turn in json_data['turns']: turn_index = turn['turn-index'] speaker = turn['speaker'] utterance = turn['utterance'] if turn_index != 0: if speaker == 'U': u_text = '' u_text = utterance else: a = '' for annotate in turn['annotations']: a = annotate['breakdown'] tmp1 = str(a) + '\t' + u_text tmp2 = tmp1.split('\t') label_text.append(tmp2) # 重複を削除し、破綻ではない発話のみを抽出 df_label_text = pd.DataFrame(label_text) df_label_text = df_label_text.drop_duplicates() df_label_text_O = df_label_text[df_label_text[0] == 'O'] # Janomeによる形態素解析 t = Tokenizer() morpO = [] tmp1 = [] tmp2 = '' for row in df_label_text_O.values.tolist(): reg_row = re.sub('[0-9a-zA-Z]+', '', row[1]) reg_row = reg_row.replace('\n', '') for token in t.tokenize(reg_row): tmp1.append(token.surface) tmp2 = ' '.join(tmp1) morpO.append(tmp2) tmp1 = [] # TF-IDF値による重みありの単語文書行列を作成 morpO_array = np.array(morpO) tfidf_vecO = TfidfVectorizer(use_idf=True) morpO_tfidf_vecs = tfidf_vecO.fit_transform(morpO_array) morpO_tfidf_array = morpO_tfidf_vecs.toarray() # DataFrame形式に変換し、相関行列を作成 dtmO = pd.DataFrame(morpO_tfidf_array, columns=tfidf_vecO.get_feature_names(), index=morpO) corr_matrixO = dtmO.corr().abs() # 相関行列`corr_matrixO`を列方向から行方向へ変換してください corr_stackO = corr_matrixO.stack() index = pd.Series(corr_stackO.index.values) value = pd.Series(corr_stackO.values) # 相関係数が0.5以上1.0未満のものを抽出 tmp3 = [] # 相関係数が0.5以上1.0未満の値を持つindex値のリスト tmp4 = [] # 相関係数が0.5以上1.0未満のvalue値のリスト for i in range(0, len(index)): if value[i] >= 0.5 and value[i] < 1.0: tmp1 = str(index[i][0]) + ' ' + str(index[i][1]) tmp2 = [s for s in tmp1.split()] tmp3.append(tmp2) tmp4 = np.append(tmp4, value[i]) tmp3 = pd.DataFrame(tmp3) tmp3 = tmp3.rename(columns={0: 'node1', 1: 'node2'}) tmp4 = pd.DataFrame(tmp4) tmp4 = tmp4.rename(columns={0: 'weight'}) # DataFrame`tmp3`と`tmp4`を横方向に連結してください df_corlistO = pd.concat([tmp3, tmp4], axis=1) # 作成したDataFrameを表示 df_corlistO.head(20)類似度ネットワークの作成

ネットワークは対象と対象の 関係を表現する方法の一つです。

有名な例として、SNSにおける友だち関係のネットワークがあります。ネットワーク構造では 対象はノードで 関係はエッジで表現されます。エッジは重みを持ち、友だち関係のネットワークにおいては親密度にあたります。

親密であればあるほど重みの値は大きくなります。他にも、路線図や航空網、単語の共起・類似関係もネットワークで表現できます。

前節で作成した類似度リストのように、エッジに方向の概念がなく関係性のない言語群を可視化するには

無向グラフ(または 無向ネットワーク)を利用します。なお、重み付きのグラフをネットワークとも呼びます。

無向グラフとは、ネットワークを構成するエッジが方向性を持たないものです。

それとは逆に、エッジが方向性を持つものを有向グラフ(または有向ネットワーク)と呼びます。無向グラフ(無向ネットワーク)の作成

Pythonには NetworkX と呼ばれるライブラリがあります。

本セクションではこのライブラリを用いて、前節で作成した類似度リストの可視化を行います。# ライブラリ`NetworkX`をimport import networkx as nx # 無向グラフの作成 network = nx.from_pandas_edgelist(df, source='source', target='target', edge_attr=None, create_using=None)①df:グラフの元となるPandasのDataFrame名 ②source:ソースノードの列名 str(文字列型)またはint(整数型)で指定する ③target:対象ノードの列名 strまたはintで指定する ④edge_attr:それぞれのデータのエッジ(重み) strまたはint、iterable、Trueで指定する ⑤create_using:グラフのタイプ(オプション) 無向グラフ:nx.Graph(デフォルト) 有向グラフ:nx.DiGraphグラフ(ネットワーク)の可視化

# ライブラリ`Matplotlib`から`pyplot`をimport from matplotlib import pyplot # 各ノードの最適な表示位置を計算 pos = nx.spring_layout(graph) # グラフを描画 nx.draw_networkx(graph, pos) # Matplolibを用いてグラフを表示 plt.show()使用例はこちら

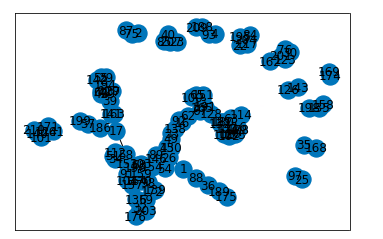

import os import json import pandas as pd import numpy as np import re from janome.tokenizer import Tokenizer from sklearn.feature_extraction.text import TfidfVectorizer import networkx as nx import matplotlib.pyplot as plt # init100ディレクトリを指定 file_path = './6110_nlp_preprocessing_data/init100/' file_dir = os.listdir(file_path) # フラグと発話内容を抽出したリストを作成 label_text = [] for file in file_dir[:10]: r = open(file_path + file, 'r', encoding='utf-8') json_data = json.load(r) for turn in json_data['turns']: turn_index = turn['turn-index'] speaker = turn['speaker'] utterance = turn['utterance'] if turn_index != 0: if speaker == 'U': u_text = '' u_text = utterance else: a = '' for annotate in turn['annotations']: a = annotate['breakdown'] tmp1 = str(a) + '\t' + u_text tmp2 = tmp1.split('\t') label_text.append(tmp2) # 重複を削除し、破綻ではない発話のみを抽出 df_label_text = pd.DataFrame(label_text) df_label_text = df_label_text.drop_duplicates() df_label_text_O = df_label_text[df_label_text[0] == 'O'] # Janomeによる形態素解析 t = Tokenizer() morpO = [] tmp1 = [] tmp2 = '' for row in df_label_text_O.values.tolist(): reg_row = re.sub('[0-9a-zA-Z]+', '', row[1]) reg_row = reg_row.replace('\n', '') for token in t.tokenize(reg_row): tmp1.append(token.surface) tmp2 = ' '.join(tmp1) morpO.append(tmp2) tmp1 = [] # TF-IDF値による重みありの単語文書行列を作成 morpO_array = np.array(morpO) tfidf_vecO = TfidfVectorizer(use_idf=True) morpO_tfidf_vecs = tfidf_vecO.fit_transform(morpO_array) morpO_tfidf_array = morpO_tfidf_vecs.toarray() # DataFrame形式に変換し、相関行列を作成 dtmO = pd.DataFrame(morpO_tfidf_array) corr_matrixO = dtmO.corr().abs() # 破綻ではない発話データセットの作成 corr_stackO = corr_matrixO.stack() index = pd.Series(corr_stackO.index.values) value = pd.Series(corr_stackO.values) tmp3 = [] tmp4 = [] for i in range(0, len(index)): if value[i] >= 0.5 and value[i] < 1.0: tmp1 = str(index[i][0]) + ' ' + str(index[i][1]) tmp2 = [int(s) for s in tmp1.split()] tmp3.append(tmp2) tmp4 = np.append(tmp4, value[i]) tmp3 = pd.DataFrame(tmp3) tmp3 = tmp3.rename(columns={0: 'node1', 1: 'node2'}) tmp4 = pd.DataFrame(tmp4) tmp4 = tmp4.rename(columns={0: 'weight'}) df_corlistO = pd.concat([tmp3, tmp4], axis=1) # ①無向グラフを作成 G_corlistO = nx.from_pandas_edgelist(df_corlistO, 'node1', 'node2', ['weight']) # ②作成したグラフを可視化 # レイアウトの設定 pos = nx.spring_layout(G_corlistO) nx.draw_networkx(G_corlistO, pos) plt.show()類似度ネットワークの特徴

前節で可視化したグラフのように、実際のネットワークは複雑な構造が多いため

一見して特徴を把握することは困難です。このような場合には、何らかの指標をもって定量的に特徴を把握します。

その指標には、ネットワーク全体を把握するためのもの(大域的)もあれば

あるノードに着目して把握するもの(局所的)もあります。一般的に使用されている指標の例をいくつか挙げます。

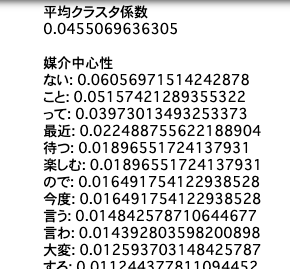

次数:ノードが持つエッジの本数を表します。 次数分布:ある次数を持つノード数のヒストグラムを表します。 クラスタ係数:ノード間がどの程度密に繋がっているかを表します。 経路長:あるノードから他のノードへ至るまでの距離です。 中心性:あるノードがネットワークにおいて中心的な役割を果たす度合いを表します。それでは、前節で作成したネットワークについて、クラスタ係数と媒介中心性を計算し

特徴を見ていきます。このネットワークでは

クラスタ係数は単語間のつながり密度を

媒介中心性はネットワークにおける単語のハブ度合いを表します。破綻ではない発話と破綻である発話、それぞれのネットワークにおいて平均クラスタ係数を比較すると

破綻である発話の単語のほうが密につながっていることが分かります。また、媒介中心性の高い上位5単語を比較してみると

破綻ではない発話にはお盆休みに関する単語が

破綻である発話には早朝の野球に関する単語が中心的な役割を果たしていると推測できます。①破綻ではない発話 <平均クラスタ係数> 0.051924357 <媒介中心性の高い上位5単語> 休み、お盆、ここ、少ない、明け ②破綻である発話 <平均クラスタ係数> 0.069563257 <媒介中心性の高い上位5単語> 今度、ましょ、野球、早朝、かれ使用例はこちら

import os import json import pandas as pd import numpy as np import re from janome.tokenizer import Tokenizer from sklearn.feature_extraction.text import TfidfVectorizer import networkx as nx import matplotlib.pyplot as plt # init100ディレクトリを指定 file_path = './6110_nlp_preprocessing_data/init100/' file_dir = os.listdir(file_path) # フラグと発話内容を抽出したリストを作成 label_text = [] for file in file_dir[:10]: r = open(file_path + file, 'r', encoding='utf-8') json_data = json.load(r) for turn in json_data['turns']: turn_index = turn['turn-index'] speaker = turn['speaker'] utterance = turn['utterance'] if turn_index != 0: if speaker == 'U': u_text = '' u_text = utterance else: a = '' for annotate in turn['annotations']: a = annotate['breakdown'] tmp1 = str(a) + '\t' + u_text tmp2 = tmp1.split('\t') label_text.append(tmp2) # 重複を削除し、破綻ではない発話のみを抽出 df_label_text = pd.DataFrame(label_text) df_label_text = df_label_text.drop_duplicates() df_label_text_O = df_label_text[df_label_text[0] == 'O'] # Janomeによる形態素解析 t = Tokenizer() morpO = [] tmp1 = [] tmp2 = '' for row in df_label_text_O.values.tolist(): reg_row = re.sub('[0-9a-zA-Z]+', '', row[1]) reg_row = reg_row.replace('\n', '') for token in t.tokenize(reg_row): tmp1.append(token.surface) tmp2 = ' '.join(tmp1) morpO.append(tmp2) tmp1 = [] # TF-IDF値による重みありの単語文書行列を作成 morpO_array = np.array(morpO) tfidf_vecO = TfidfVectorizer(use_idf=True) morpO_tfidf_vecs = tfidf_vecO.fit_transform(morpO_array) morpO_tfidf_array = morpO_tfidf_vecs.toarray() # DataFrame形式に変換し、相関行列を作成 dtmO = pd.DataFrame(morpO_tfidf_array, columns=tfidf_vecO.get_feature_names(), index=morpO) corr_matrixO = dtmO.corr().abs() # 破綻ではない発話データセットの作成 corr_stackO = corr_matrixO.stack() index = pd.Series(corr_stackO.index.values) value = pd.Series(corr_stackO.values) tmp3 = [] tmp4 = [] for i in range(0, len(index)): if value[i] >= 0.5 and value[i] < 1.0: tmp1 = str(index[i][0]) + ' ' + str(index[i][1]) tmp2 = [s for s in tmp1.split()] tmp3.append(tmp2) tmp4 = np.append(tmp4, value[i]) tmp3 = pd.DataFrame(tmp3) tmp3 = tmp3.rename(columns={0: 'node1', 1: 'node2'}) tmp4 = pd.DataFrame(tmp4) tmp4 = tmp4.rename(columns={0: 'weight'}) df_corlistO = pd.concat([tmp3, tmp4], axis=1) # 無向グラフを作成 G_corlistO = nx.from_pandas_edgelist(df_corlistO, 'node1', 'node2', ['weight']) # 破綻ではない発話データセットに対して # ①平均クラスタ係数の計算 print('平均クラスタ係数') print(nx.average_clustering(G_corlistO, weight='weight')) print() # ②媒介中心性の計算 bc = nx.betweenness_centrality(G_corlistO, weight='weight') print('媒介中心性') for k, v in sorted(bc.items(), key=lambda x: -x[1]): print(str(k) + ': ' + str(v))平均クラスタ係数の計算

すべてのノードのクラスタ係数の平均が高いほど、そのネットワークは密であると言えます。

クラスタ係数の平均はnx.average_clustering()を用いて算出します。nx.average_clustering(G, weight=None)①G graphを指定します。 (前節で作成した無向グラフG_corlistOのこと) ②weight 重みとして使用する数値を持つエッジを指定します。Noneの場合、各エッジの重みは1になります。媒介中心性の計算

あるノードがすべてのノード間の最短経路中にいくつ含まれているかによって求められます。

つまり、情報を効率的に伝える際に最も利用されるノードほど媒介性が高く、中心的であると言えます。nx.betweenness_centrality(G, weight=None)①G graphを指定します。 (前節で作成した無向グラフG_corlistOのこと) ②weight 重みとして使用する数値を持つエッジを指定します。Noneの場合、すべてのエッジの重みは等しいとみなされます。類似度ネットワークのトピック抽出

一つのネットワークは、複数の部分ネットワーク(=コミュニティ)によって成り立っています。

コミュニティ内の各ノードは、エッジで密につながっていることが特徴です。一つのネットワークの疎なエッジを取り除くと部分ネットワークに分割できます。

つまり、コミュニティが抽出できる=類似度の高いネットワークの抽出ができるということです。ネットワークの分割には

モジュラリティ(Modularity)と呼ばれる指標を用います。モジュラリティは

「一つのネットワークの総エッジ数に対するコミュニティ内のエッジ数の割合」から

「一つのネットワークのすべてのノードの出次数の合計(ネットワークのエッジ数 × 2 と等しい)に対する

コミュニティ内のノードの出次数の合計の割合」を引いた値で、分割の質を定量化します。モジュラリティの値が大きいほど、コミュニティ内のノードは密につながっていると言えます。

それでは、モジュラリティを用いてコミュニティを抽出してみます。

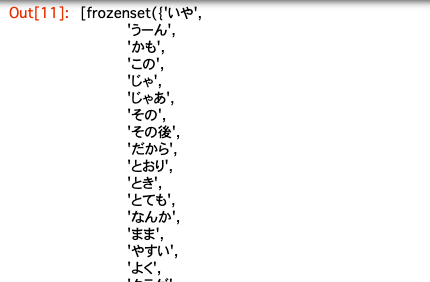

破綻ではない発話と破綻である発話、それぞれのネットワークにおいて

所属するノード数が最も多いコミュニティの単語を確認すると以下のような結果を得ました。①破綻ではない発話 お盆,しまい,ついつい,休み,切れ,困り,少ない,帰省,忘れ,怠け者,明け,続く,連休,集中 ②破綻である発話 お願い,くらい,ぐらい,それから,とる,どの,はまっ,もちろん,よい,作業,偏ら,割り勘,危険,待っ,心掛け,時間,栄養,油断,睡眠,食事破綻ではない発話には、例えば「お盆休みが少なくて帰省に困る」「連休が続くと休み明けに怠ける」などの

トピックがありそうだと推測できます。破綻である発話には、例えば「食事の栄養が偏らないように心がける」「十分な時間の睡眠をとる」などの

トピックがありそうです。同様に、他のコミュニティにもどのようなトピックが含まれているか単語から推測できるはずです。

モジュラリティを用いたコミュニティの抽出

greedy_modularity_communities(G, weight=None)①G graphを指定します。 (前節で作成した無向グラフG_corlistOのこと) ②weight 重みとして使用する数値を持つエッジを指定します。Noneの場合、すべてのエッジの重みは等しいとみなされます。使用例はこちら

import os import json import pandas as pd import numpy as np import re from janome.tokenizer import Tokenizer from sklearn.feature_extraction.text import TfidfVectorizer import networkx as nx import matplotlib.pyplot as plt from networkx.algorithms.community import greedy_modularity_communities # init100ディレクトリを指定 file_path = './6110_nlp_preprocessing_data/init100/' file_dir = os.listdir(file_path) # フラグと発話内容を抽出したリストを作成 label_text = [] for file in file_dir[:20]: r = open(file_path + file, 'r', encoding='utf-8') json_data = json.load(r) for turn in json_data['turns']: turn_index = turn['turn-index'] speaker = turn['speaker'] utterance = turn['utterance'] if turn_index != 0: if speaker == 'U': u_text = '' u_text = utterance else: a = '' for annotate in turn['annotations']: a = annotate['breakdown'] tmp1 = str(a) + '\t' + u_text tmp2 = tmp1.split('\t') label_text.append(tmp2) # 重複を削除し、破綻ではない発話のみを抽出 df_label_text = pd.DataFrame(label_text) df_label_text = df_label_text.drop_duplicates() df_label_text_O = df_label_text[df_label_text[0] == 'O'] # Janomeによる形態素解析 t = Tokenizer() morpO = [] tmp1 = [] tmp2 = '' for row in df_label_text_O.values.tolist(): reg_row = re.sub('[0-9a-zA-Z]+', '', row[1]) reg_row = reg_row.replace('\n', '') for token in t.tokenize(reg_row): tmp1.append(token.surface) tmp2 = ' '.join(tmp1) morpO.append(tmp2) tmp1 = [] # TF-IDF値による重みありの単語文書行列を作成 morpO_array = np.array(morpO) tfidf_vecO = TfidfVectorizer(use_idf=True) morpO_tfidf_vecs = tfidf_vecO.fit_transform(morpO_array) morpO_tfidf_array = morpO_tfidf_vecs.toarray() # DataFrame形式に変換し、相関行列を作成 dtmO = pd.DataFrame(morpO_tfidf_array, columns=tfidf_vecO.get_feature_names(), index=morpO) corr_matrixO = dtmO.corr().abs() # 破綻ではない発話データセットの作成 corr_stackO = corr_matrixO.stack() index = pd.Series(corr_stackO.index.values) value = pd.Series(corr_stackO.values) tmp3 = [] tmp4 = [] for i in range(0, len(index)): if value[i] >= 0.5 and value[i] < 1.0: tmp1 = str(index[i][0]) + ' ' + str(index[i][1]) tmp2 = [s for s in tmp1.split()] tmp3.append(tmp2) tmp4 = np.append(tmp4, value[i]) tmp3 = pd.DataFrame(tmp3) tmp3 = tmp3.rename(columns={0: 'node1', 1: 'node2'}) tmp4 = pd.DataFrame(tmp4) tmp4 = tmp4.rename(columns={0: 'weight'}) df_corlistO = pd.concat([tmp3, tmp4], axis=1) # 無向グラフを作成 G_corlistO = nx.from_pandas_edgelist(df_corlistO, 'node1', 'node2', ['weight']) # 破綻ではない発話データセットに対して # コミュニティ抽出 cm_corlistO = list(greedy_modularity_communities(G_corlistO, weight='weight')) # 各コミュニティに属するノードの表示 cm_corlistO

- 投稿日:2020-05-21T22:08:50+09:00

韻を扱いたいpart2

内容

前回入力データの分割方法に改良が必要なのでは?と感じたため、様々な分割方法を試してみる。入力データは前回同様某ラッパーの歌詞を使用。一応検証用として自分が温めていた韻をテーマにしたものも用意している。

分かち書きの場合

import MeCab mecab = MeCab.Tagger("-Owakati") mecab_text = mecab.parse(data).split()歌詞通りの「韻」を抽出できている部分もあるが、「数万円」で踏んでいるところが分かち書きによって「数、万、円」と分割されているため認識できていない。余談だが、

kakashiのconv.doに一度に多くのデータは渡せないようだ。text_data = [conv.do(text) for text in mecab_text]とした。ちなみに分かち書き後、母音に変換したwordの長さは最大8文字、平均2.16文字であった。細かく分け過ぎているので、分かち書きでの分割は適していないと言える。

このMeCabを使えるようにするまでに何回も挫けた。色んな記事を見過ぎたのかもしれない。こちらに感謝N-gramの場合

では、単にN文字ごとに分割していくとどうなるだろう。Nは4から試してみる。

def make_ngram(words, N): ngram = [] for i in range(len(words)-N+1): #全角スペースと改行を取り除く row = "".join(words[i:i+N]).replace("\u3000","").replace("\n","") ngram.append(row) return ngram体感だが、Nは5かそれ以上が良さそうである。(4以下だとスコアの差が付かない)そこそこ歌詞通りに韻を検出できている。試しに検証用データを入れてみると、一見気づかない韻が検出できた。wordが様々な切り取られ方をするのだから、スコアの付け方を変えてみる。

def make_score_ngram(word_a, word_b): score = 0 for i in range(len(word_a)): if word_a[-i:] == word_b[-i:]: score += i return score母音の一致を語尾から見ることによって、出力が見やすい。Nの値については

len(target_word_vo)(韻を探す元の言葉の母音の長さ)が良いだろう。自分がやりたいことが表現できてしまったような気がしている。

折角苦労してMeCabを使用できるようにして、「韻の数値化」も自分なりに考えたので、使いたい。この2つを組み合わせてみる。target_wordが絞れるのでは?!

「韻の数値化」では母音が合致する部分を探索し、合致している長さ

len(word[i:j)をスコアにしていた。このword[i:j]は「eoi」等の形をしており、この出現回数をカウントすれば、入力データ中で一番登場する母音が分かるはずだ。それを含む言葉をtarget_wordに指定すれば、多くのレコメンドが見込めるという考えである。申し訳程度に分かち書きと検証用に用意したテキストを使う。from pykakasi import kakasi import re from collections import defaultdict import MeCab with open("./test.txt","r",encoding="utf-8") as f: data = f.read() mecab = MeCab.Tagger("-Owakati") mecab_text = mecab.parse(data).split() kakasi = kakasi() kakasi.setMode('H', 'a') kakasi.setMode('K', 'a') kakasi.setMode('J', 'a') conv = kakasi.getConverter() text_data = [conv.do(text) for text in mecab_text] vowel_data = [re.sub(r"[^aeiou]+","",text) for text in text_data] dic_vo = {k:v for k,v in enumerate(vowel_data)} #voel_dataのインデックスで母音変換前のdataが分かるように辞書作成。 dic = {k:v for k,v in enumerate(mecab_text)} #新たなキーを追加する際に初期化を省きたいためdefaultdictを使用{母音:出現回数} dic_rhyme = defaultdict(int) for word_a in vowel_data: for word_b in vowel_data: if len(word_a) > len(word_b): word_len = len(word_b) for i in range(word_len): for j in range(word_len + 1): #カウントするのは2文字以上に限定 if word_b[i:j] in word_a and not len(word_b[i:j])<2: dic_rhyme[word_b[i:j]] += 1 else: word_len = len(word_a) for i in range(word_len): for j in range(word_len + 1): if word_a[i:j] in word_b and not len(word_a[i:j])<2: dic_rhyme[word_a[i:j]] += 1 #カウントが多かった順にソート dic_rhyme = sorted(dic_rhyme.items(), key=lambda x:x[1], reverse=True) print(dic_rhyme) #dic_rhymeの上位にきたものが含まれているものを探索。ここでは"ai"を使用 bool_index = ["ai" in text for text in vowel_data] for i in range(len(vowel_data)): if bool_index[i]: print(dic[i])登場頻度の高い母音の並びを取得し、どこで使われているか出力できた。しかしながら、分かち書きで細分化された言葉は分かりにくくなっていた。もしかしたら、もう少し長い韻があった可能性もある。

改良点

target_wordを絞るという用途では必要性を感じないが(自分が一番言いたいことを指定したいため)、どの母音の並びが頻出なのかは確認できても良いかもしれない。分かち書きで上手くいかなかったが、MeCabを利用して(

何度もいうが、使えるようになるまで四苦八苦した)改良したい。

また、N-gramを採用したことによって「韻の数値化」も簡潔にできたので、もう少し複雑に「韻」を定義し直せないか考える。(現状「っ」など考慮していない)

しかし、回り道をした。「韻の数値化」は韻を漏らさないよう、入力データに対応できるよう、自分なりに考え抜いたつもりのものだ。まさか引数を様々にスライスすることが入力データを様々にスライス(表現が違うかもしれません)で解決できるとは…というかそれに気付かないとは。基本が大事ですね。でもN-gramって意味のない日本語が出来ると感じませんか?ただ、「韻」の部分を強調して発音する等やり方はあるんです。やはり、簡単なデータ使ってとにかくやってみることが大事ってことですわ。

- 投稿日:2020-05-21T21:34:34+09:00

【自然言語処理100本ノック 2020】第2章: UNIXコマンド

はじめに

自然言語処理の問題集として有名な自然言語処理100本ノックの2020年版が4/6に公開されました。

この記事では、以下の第1章から第10章のうち、第2章: UNIXコマンドを解いてみた結果をまとめています。

- 第1章: 準備運動

- 第2章: UNIXコマンド

- 第3章: 正規表現

- 第4章: 形態素解析

- 第5章: 係り受け解析

- 第6章: 機械学習

- 第7章: 単語ベクトル

- 第8章: ニューラルネット

- 第9章: RNN, CNN

- 第10章: 機械翻訳

事前準備

回答にはGoogle Colaboratoryを利用しています。

Google Colaboratoryのセットアップ方法や基本的な使い方は、こちらの記事が詳しいです。

なお、以降の回答の実行結果を含むノートブックはgithubにて公開しています。第2章: UNIXコマンド

popular-names.txtは,アメリカで生まれた赤ちゃんの「名前」「性別」「人数」「年」をタブ区切り形式で格納したファイルである.以下の処理を行うプログラムを作成し,popular-names.txtを入力ファイルとして実行せよ.さらに,同様の処理をUNIXコマンドでも実行し,プログラムの実行結果を確認せよ.

まずは指定のデータをダウンロードします。

Google Colaboratoryのセル上で下記のコマンドを実行すると、カレントディレクトリに対象のテキストファイルがダウンロードされます。!wget https://nlp100.github.io/data/popular-names.txt【 wget 】コマンド――URLを指定してファイルをダウンロードする

10. 行数のカウント

行数をカウントせよ.確認にはwcコマンドを用いよ.

早速問題を解いていきます。

今回はpandasのデータフレームとして読み込んでから各問の処理を行っていきます。また、問題文の指示に従い、コマンドでの結果の確認も行っています。import pandas as pd df = pd.read_table('./popular-names.txt', header=None, sep='\t', names=['name', 'sex', 'number', 'year']) print(len(df)) # 確認 !cat ./popular-names.txt | wc -lpandasでcsv/tsvファイル読み込み

pandasで行数、列数、全要素数(サイズ)を取得

【 cat 】コマンド――設定ファイルの内容を簡単に確認する

【 wc 】コマンド――テキストファイルの文字数や行数を数える11. タブをスペースに置換

タブ1文字につきスペース1文字に置換せよ.確認にはsedコマンド,trコマンド,もしくはexpandコマンドを用いよ.

本問は、元データの区切り文字であるタブの置換を想定していると思われるため、すでに読み込んでいるデータフレームでは実施せず、コマンドでの確認のみ行っています。

# 確認 !sed -e 's/\t/ /g' ./popular-names.txt【 sed 】コマンド(基礎編その4)――文字列を置き換える/置換した行を出力する

12. 1列目をcol1.txtに,2列目をcol2.txtに保存

各行の1列目だけを抜き出したものをcol1.txtに,2列目だけを抜き出したものをcol2.txtとしてファイルに保存せよ.確認にはcutコマンドを用いよ.

col1 = df['name'].copy() col1.to_csv('./col1.txt', index=False) # 確認 !cut -f 1 ./popular-names.txt > ./col1_chk.txt !cat ./col1_chk.txtcol2 = df['sex'].copy() col2.to_csv('./col2.txt', index=False) # 確認 !cut -f 2 ./popular-names.txt > ./col2_chk.txt !cat ./col2_chk.txtpandasのインデックス参照で行・列を選択し取得

pandasでcsvファイルの書き出し

【 cut 】コマンド――行から固定長またはフィールド単位で切り出す

コマンドの実行結果・標準出力をファイルに保存13. col1.txtとcol2.txtをマージ

12で作ったcol1.txtとcol2.txtを結合し,元のファイルの1列目と2列目をタブ区切りで並べたテキストファイルを作成せよ.確認にはpasteコマンドを用いよ.

col1 = pd.read_table('./col1.txt') col2 = pd.read_table('./col2.txt') merged_1_2 = pd.concat([col1, col2], axis=1) merged_1_2.to_csv('./merged_1_2.txt', sep='\t', index=False) # 確認 !paste ./col1_chk.txt ./col2_chk.txtpandas.DataFrame, Seriesを連結する

【 paste 】コマンド――複数のファイルを行単位で連結する14. 先頭からN行を出力

自然数Nをコマンドライン引数などの手段で受け取り,入力のうち先頭のN行だけを表示せよ.確認にはheadコマンドを用いよ.

def output_head(N): print(df.head(N)) output_head(10) # 確認 !head -n 10 ./popular-names.txtPythonで関数を定義・呼び出し

pandas.DataFrame, Seriesの先頭・末尾の行を返す

【 head 】コマンド/【 tail 】コマンド――長いメッセージやテキストファイルの先頭だけ/末尾だけを表示する15. 末尾のN行を出力

自然数Nをコマンドライン引数などの手段で受け取り,入力のうち末尾のN行だけを表示せよ.確認にはtailコマンドを用いよ.

def output_tail(N): print(df.tail(N)) output_tail(10) # 確認 !tail -n 10 ./popular-names.txt16. ファイルをN分割する

自然数Nをコマンドライン引数などの手段で受け取り,入力のファイルを行単位でN分割せよ.同様の処理をsplitコマンドで実現せよ.

いろいろなやり方があると思いますが、ここではレコードの通番に対して、対象の数値の大きさで等分するqcutを適用することでファイルをN分割しています。

def split_file(N): tmp = df.reset_index(drop=False) df_cut = pd.qcut(tmp.index, N, labels=[i for i in range(N)]) print(df_cut.value_counts()) df_cut = pd.concat([df, pd.Series(df_cut, name='sp')], axis=1) return df_cut df_cut = split_file(10) print(df_cut.head()) # 確認 !split -l 200 -d ./popular-names.txt sppandas.DataFrame, Seriesのインデックスを振り直す

pandasのcut, qcut関数でビニング処理(ビン分割)

pandasでユニークな要素の個数、頻度(出現回数)をカウント

【 split 】コマンド――ファイルを分割する17. 1列目の文字列の異なり

1列目の文字列の種類(異なる文字列の集合)を求めよ.確認にはcut, sort, uniqコマンドを用いよ.

print(len(df.drop_duplicates(subset='name'))) # 確認 !cut -f 1 ./popular-names.txt | sort | uniq | wc -lpandas.DataFrame, Seriesの重複した行を抽出・削除

【 sort 】コマンド――テキストファイルを行単位で並べ替える

【 uniq 】コマンド――重複している行を削除する18. 各行を3コラム目の数値の降順にソート

各行を3コラム目の数値の逆順で整列せよ(注意: 各行の内容は変更せずに並び替えよ).確認にはsortコマンドを用いよ(この問題はコマンドで実行した時の結果と合わなくてもよい).

df.sort_values(by='number', ascending=False, inplace=True) print(df.head()) # 確認 !cat ./popular-names.txt | sort -rnk 3pandas.DataFrame, Seriesをソートする

19. 各行の1コラム目の文字列の出現頻度を求め,出現頻度の高い順に並べる

各行の1列目の文字列の出現頻度を求め,その高い順に並べて表示せよ.確認にはcut, uniq, sortコマンドを用いよ.

print(df['name'].value_counts().sort_values(ascending=False)) # 確認 !cut -f 1 ./popular-names.txt | sort | uniq -c | sort -rnおわりに

自然言語処理100本ノックは自然言語処理そのものだけでなく、基本的なデータ処理や汎用的な機械学習についてもしっかり学ぶことができるように作られています。

オンラインコースなどで機械学習を勉強中の方も、とても良いアウトプットの練習になると思いますので、ぜひ挑戦してみてください。

- 投稿日:2020-05-21T21:34:34+09:00

【自然言語処理100本ノック 2020】第2章の回答例

はじめに

自然言語処理の問題集として有名な自然言語処理100本ノックの2020年版が4/6に公開されました。

この記事では、以下の第1章から第10章のうち、第2章: UNIXコマンドを解いてみた結果をまとめています。

- 第1章: 準備運動

- 第2章: UNIXコマンド

- 第3章: 正規表現

- 第4章: 形態素解析

- 第5章: 係り受け解析

- 第6章: 機械学習

- 第7章: 単語ベクトル

- 第8章: ニューラルネット

- 第9章: RNN, CNN

- 第10章: 機械翻訳

事前準備

回答にはGoogle Colaboratoryを利用しています。

Google Colaboratoryのセットアップ方法や基本的な使い方は、こちらの記事が詳しいです。

なお、以降の回答の実行結果を含むノートブックはgithubにて公開しています。第2章: UNIXコマンド

popular-names.txtは,アメリカで生まれた赤ちゃんの「名前」「性別」「人数」「年」をタブ区切り形式で格納したファイルである.以下の処理を行うプログラムを作成し,popular-names.txtを入力ファイルとして実行せよ.さらに,同様の処理をUNIXコマンドでも実行し,プログラムの実行結果を確認せよ.

まずは指定のデータをダウンロードします。

Google Colaboratoryのセル上で下記のコマンドを実行すると、カレントディレクトリに対象のテキストファイルがダウンロードされます。!wget https://nlp100.github.io/data/popular-names.txt【 wget 】コマンド――URLを指定してファイルをダウンロードする

10. 行数のカウント

行数をカウントせよ.確認にはwcコマンドを用いよ.

早速問題を解いていきます。

今回はpandasのデータフレームとして読み込んでから各問の処理を行っていきます。また、問題文の指示に従い、コマンドでの結果の確認も行っています。import pandas as pd df = pd.read_table('./popular-names.txt', header=None, sep='\t', names=['name', 'sex', 'number', 'year']) print(len(df)) # 確認 !cat ./popular-names.txt | wc -lpandasでcsv/tsvファイル読み込み

pandasで行数、列数、全要素数(サイズ)を取得

【 cat 】コマンド――設定ファイルの内容を簡単に確認する

【 wc 】コマンド――テキストファイルの文字数や行数を数える11. タブをスペースに置換

タブ1文字につきスペース1文字に置換せよ.確認にはsedコマンド,trコマンド,もしくはexpandコマンドを用いよ.

本問は、元データの区切り文字であるタブの置換を想定していると思われるため、すでに読み込んでいるデータフレームでは実施せず、コマンドでの確認のみ行っています。

# 確認 !sed -e 's/\t/ /g' ./popular-names.txt【 sed 】コマンド(基礎編その4)――文字列を置き換える/置換した行を出力する

12. 1列目をcol1.txtに,2列目をcol2.txtに保存

各行の1列目だけを抜き出したものをcol1.txtに,2列目だけを抜き出したものをcol2.txtとしてファイルに保存せよ.確認にはcutコマンドを用いよ.

col1 = df['name'].copy() col1.to_csv('./col1.txt', index=False) # 確認 !cut -f 1 ./popular-names.txt > ./col1_chk.txt !cat ./col1_chk.txtcol2 = df['sex'].copy() col2.to_csv('./col2.txt', index=False) # 確認 !cut -f 2 ./popular-names.txt > ./col2_chk.txt !cat ./col2_chk.txtpandasのインデックス参照で行・列を選択し取得

pandasでcsvファイルの書き出し

【 cut 】コマンド――行から固定長またはフィールド単位で切り出す

コマンドの実行結果・標準出力をファイルに保存13. col1.txtとcol2.txtをマージ

12で作ったcol1.txtとcol2.txtを結合し,元のファイルの1列目と2列目をタブ区切りで並べたテキストファイルを作成せよ.確認にはpasteコマンドを用いよ.

col1 = pd.read_table('./col1.txt') col2 = pd.read_table('./col2.txt') merged_1_2 = pd.concat([col1, col2], axis=1) merged_1_2.to_csv('./merged_1_2.txt', sep='\t', index=False) # 確認 !paste ./col1_chk.txt ./col2_chk.txtpandas.DataFrame, Seriesを連結する

【 paste 】コマンド――複数のファイルを行単位で連結する14. 先頭からN行を出力

自然数Nをコマンドライン引数などの手段で受け取り,入力のうち先頭のN行だけを表示せよ.確認にはheadコマンドを用いよ.

def output_head(N): print(df.head(N)) output_head(10) # 確認 !head -n 10 ./popular-names.txtPythonで関数を定義・呼び出し

pandas.DataFrame, Seriesの先頭・末尾の行を返す

【 head 】コマンド/【 tail 】コマンド――長いメッセージやテキストファイルの先頭だけ/末尾だけを表示する15. 末尾のN行を出力

自然数Nをコマンドライン引数などの手段で受け取り,入力のうち末尾のN行だけを表示せよ.確認にはtailコマンドを用いよ.

def output_tail(N): print(df.tail(N)) output_tail(10) # 確認 !tail -n 10 ./popular-names.txt16. ファイルをN分割する

自然数Nをコマンドライン引数などの手段で受け取り,入力のファイルを行単位でN分割せよ.同様の処理をsplitコマンドで実現せよ.

いろいろなやり方があると思いますが、ここではレコードの通番に対して、対象の数値の大きさで等分するqcutを適用することでファイルをN分割しています。

def split_file(N): tmp = df.reset_index(drop=False) df_cut = pd.qcut(tmp.index, N, labels=[i for i in range(N)]) print(df_cut.value_counts()) df_cut = pd.concat([df, pd.Series(df_cut, name='sp')], axis=1) return df_cut df_cut = split_file(10) print(df_cut.head()) # 確認 !split -l 200 -d ./popular-names.txt sppandas.DataFrame, Seriesのインデックスを振り直す

pandasのcut, qcut関数でビニング処理(ビン分割)

pandasでユニークな要素の個数、頻度(出現回数)をカウント

【 split 】コマンド――ファイルを分割する17. 1列目の文字列の異なり

1列目の文字列の種類(異なる文字列の集合)を求めよ.確認にはcut, sort, uniqコマンドを用いよ.

print(len(df.drop_duplicates(subset='name'))) # 確認 !cut -f 1 ./popular-names.txt | sort | uniq | wc -lpandas.DataFrame, Seriesの重複した行を抽出・削除

【 sort 】コマンド――テキストファイルを行単位で並べ替える

【 uniq 】コマンド――重複している行を削除する18. 各行を3コラム目の数値の降順にソート

各行を3コラム目の数値の逆順で整列せよ(注意: 各行の内容は変更せずに並び替えよ).確認にはsortコマンドを用いよ(この問題はコマンドで実行した時の結果と合わなくてもよい).

df.sort_values(by='number', ascending=False, inplace=True) print(df.head()) # 確認 !cat ./popular-names.txt | sort -rnk 3pandas.DataFrame, Seriesをソートする

19. 各行の1コラム目の文字列の出現頻度を求め,出現頻度の高い順に並べる

各行の1列目の文字列の出現頻度を求め,その高い順に並べて表示せよ.確認にはcut, uniq, sortコマンドを用いよ.

print(df['name'].value_counts().sort_values(ascending=False)) # 確認 !cut -f 1 ./popular-names.txt | sort | uniq -c | sort -rnおわりに

自然言語処理100本ノックは自然言語処理そのものだけでなく、基本的なデータ処理や汎用的な機械学習についてもしっかり学ぶことができるように作られています。

オンラインコースなどで機械学習を勉強中の方も、とても良いアウトプットの練習になると思いますので、ぜひ挑戦してみてください。

- 投稿日:2020-05-21T20:53:10+09:00

matplotlibを使ってJupyterLab上でインタラクティブな3Dグラフを作成する

1. はじめに

- インタラクティブなグラフは、数値の挙動を確認する時に何かと便利です。

- また、3Dのグラフを表示した際には、インタラクティブに見る方向を変えられると便利です。

- Jupyter notebookを使っていた頃は、ipywidgetという仕組みを使って、インタラクティブに動くグラフを作れたのですが、現時点ではJupyterLabでは対応していないように思います。

- JupyterLab上でこのような仕組みについて紹介した記事が、私が調べた限りではあまり多くはなかったように思いましたので、投稿してみようと思いました。

2. 概要

matplotlibのwidgetという仕組みを使うと、GUI backendに依存せずに、Axesに配置するような形でインタラクティブなWidgetを作ることが可能です。

以下、widgetのドキュメントからの抜粋です。

Widgets that are designed to work for any of the GUI backends. All of these widgets require you to predefine a matplotlib.axes.Axes instance and pass that as the first arg.

3. 具体的なやり方

ということで、上のようなグラフの作成方法をご説明します。なお、以下をJupyterLab上で作りましたが、先ほどのご説明の通り、matplotlib.widgetはGUI Backendに依存しないということなので、Jupyter notebookはもちろん、LinuxやWindows, MacのGUI上でも同様の結果になるものと思います。(手元では試してませんが)

(1) 必要なライブラリをインポート

まず、必要なライブラリのインポートを行います。また、バックエンドをwidgetに設定する必要があります。

%matplotlib widget import matplotlib.pyplot as plt from mpl_toolkits.mplot3d import Axes3D from matplotlib.widgets import Slider import numpy as np(2) サンプルとして表示するデータを作成

ここでは、例として、$z=x^2+2y^2$のグラフを書いてみることにします。

x = y = np.arange(-20, 20, 0.5) X, Y = np.meshgrid(x, y) Z = X*X + 2 * Y*Y(3) Figureを作成

ご存知の通り、Figureは、matplotlibでグラフを書くキャンパスのようなものです。Figureの上にAxesを載せ、その上にPlotをしていくイメージです。

# Figureの設定 fig = plt.figure(figsize=(5,5))(4) Axesの作成

次に、Figure上にAxesを作成します。

- 今回は、3Dグラフのプロット用のAxesを1つ、Slider表示用のAxesを2つ作成します。

- どんなやり方でもいいのですが、今回はgridspecを使ってみました、

- 下をコードを実行することで、図のように、Figureを20x20に分割し、1-17行目に3Dグラフ描写用のAxesを、18, 19行目にそれぞれSlider用のAxesを配置できます。

# Figureの中に3Dグラフ、Slider用のAxesを追加 axcolor = 'gold' gs = fig.add_gridspec(20, 20) ax1 = fig.add_subplot(gs[:17,:], projection='3d') ax_slider_z = fig.add_subplot(gs[18,:], facecolor=axcolor) ax_slider_xy = fig.add_subplot(gs[19,:], facecolor=axcolor)(5) Sliderの設定

次に、Sliderオブジェクトを作成します。以下のコードでは、

- slider_zとslider_xyというSiderオブジェクトを作成し、それぞれ、上で作成したax_slider_z, ax_slider_xy上に描写

- Sliderの動く範囲は-180〜180

- Sliderの初期値としてz0(=0)を設定

- Sliderの動く幅としてdelta(=10)を設定

を行っています。

# Sliderの設定 z0 = 0 xy0 = 0 delta = 10 slider_z = Slider(ax_slider_z, 'z-axis', -180, 180, valinit=z0, valstep=delta) slider_xy = Slider(ax_slider_xy, 'xy-axis', -180, 180, valinit=xy0, valstep=delta)(6) 3Dグラフの見る角度の初期値を設定後、3Dグラフを表示。

次に、3Dグラフの、z軸周り、xy平面周りの見える角度の初期値を設定します。この数値を変化させることで、3Dグラフの見る角度を動かすことができます。

# 3Dグラフの見る方向の初期値を設定 ax1.view_init(elev=z0, azim=xy0) # 3Dグラフを表示 ax1.plot_surface(X, Y, Z)(7) Sliderを動かした時に呼ばれるコールバック関数を作成

次に、Sliderを動かした時に呼ばれるコールバック関数を作成します。ここで、3Dグラフを見る角度を指定し、グラフを再描写することで動くグラフを作成することができます。

# Sliderを動かした時に呼ばれるコールバック関数 def view_change(val): sz = slider_z.val sxy = slider_xy.val ax1.view_init(elev=sxy, azim=sz) fig.canvas.draw_idle()(8) コールバック関数の設定

最後に、Sliderオブジェクトに先ほど作成したコールバック関数を設定します。

slider_z.on_changed(view_change) slider_xy.on_changed(view_change) plt.show()以上で、JupyterLab上で簡単に動くグラフを作成することができます!

こちらにgistも置いておきましたので、よろしければお使いください。(上でご説明したものと同じですが。。。)

- 投稿日:2020-05-21T20:42:50+09:00

初めてのPython ~コーディング編2~

対象者

前回の記事の続きです。

本記事では前回の記事のgraph_plot.pyを元に話題をPythonのリストや条件分岐、ループ処理に移していきます。

全部すっ飛ばしても大丈夫な人は不連続な関数を描こうへどうぞ。目次

Pythonのリスト

前回の記事では、Pythonには配列が存在しないと述べました。

その代わり、Pythonにはリスト(List)と呼ばれるデータ構造が標準搭載されています。

今回はそれについて少し触れます。リストとは

まずリストについて簡単な説明から行います。

list_sample.py

list_sample.pyx = [0, 1, 2, 3, 4, 5, 6, 7, 8, 9] print(x) x.append(10) print(x) #print(x + 3) # TypeErrorが起こる print(x + [3]) print(x * 3) x = np.array(x) print(x) x = list(x) print(x)リストは配列と似た概念で、次のように用いることができます。

list_sample.pyx = [0, 1, 2, 3, 4, 5, 6, 7, 8, 9] print(x)この

x、numpy_calc.pyで定義したxと出力結果が同じになっていることに気づきましたか?

つまり、リストと配列は似たデータ構造であることがわかります。

その最大の違いはデータサイズが可変であることです。list_sample.pyx.append(10) print(x)10が追加されましたね。

このappendメソッドはリスト型のデータ構造が持っている関数1で、要素を追加するためのものです。

もちろんnumpy配列で同じことをしようとしてもエラーが出るだけです。

numpyでは一度定義した配列のサイズを変更するには(内部処理で)どこかに改めてコピーする必要があります。

その点リストは予め大きめにメモリを確保することで、要素を追加する際にかかるメモリ確保の時間を節約することができます。

要するにそれぞれメリット/デメリットがあるということです。

他にもリストには要素を削除する関数などもあります。

また、リストにはnumpy配列のブロードキャスト機能はありません。list_sample.py#print(x + 3) # TypeErrorが起こるただし次のようなことはできます。

list_sample.pyprint(x + [3]) print(x * 3)リスト同士の足し算であれば要素の追加になります。

リストと自然数の掛け算はリストそのものを数値の数だけ繰り返したリストとなります。2

その他の演算はTypeErrorが出てできません

さらに、numpy配列とリストは相互に変換もできます。list_sample.pyx = np.array(x) print(x) x = list(x) print(x)以上で本記事で必要なリストの知識の紹介はおしまいです。

要約すると

- リストはデータサイズが可変の配列のようなもの

- numpyとリストは相互に変換できる

だけ知っておけば本記事ではOKです。

条件分岐とループ処理

条件分岐とは「ある条件を満たすなら〇〇、そうでなければ××」という処理のことです。

(この処理は人間の意思決定とも似ているところがありますね)

ループ処理とは「ある条件を満たすまで同じ処理を繰り返す」という処理のことです。

(これは機械っぽい処理ですね)では具体的にどのようにコードを書くのか、実際にやっていきましょう。

if文Pythonの条件分岐と言えば

if文だけ3です。

C言語などをやったことのある人は「え、switchとかないの?」と思うかもしれませんね。

Pythonではswitch文の類はありません。いちいち書かなければいけません。面倒ですね。

初めての人にとっては覚えることが減ってラッキーかもしれません笑。

とりあえず、この条件分岐を使ってみましょう。

if_sample.py

if_sample.pyx = 5 if x > 0: # 条件式x > 0が真ならばここの処理 print("xは0より大きいです。") else: # 条件式x > 0が偽ならばここの処理 # つまりx <= 0ならばここの処理です if x == 0: # 条件式x == 0が真ならばここの処理 # <note> # ==は式の両辺が等しいか、という条件式です # 逆に、式の両辺が等しくないか、という演算は!=です print("xは0です。") else: # 条件式x == 0が偽ならばここの処理 # つまり、x != 0ならばここの処理です print("xは0より小さいです。") if x > 0: print("xは0より大きいです。") elif x == 0: print("xは0です。") else: print("xは0より小さいです。")この二つの

if文は全く同じ動作をします。

上の方はif elseのみ、下の方はif elif elseという文法を使って書いています。

見ての通りですが、if文の中にif文を書く(ネストする、といいます)ことができます。

もちろんもっとたくさんネストさせることも可能ですが、読みにくくなってしまうのでできるだけネストは少なめにするよう心がけましょう。

つまり下の方が読みやすいコードということですね。文法まとめ

if_grammer_summary.pyif (条件式1): # (条件式1)が真(True)ならここに記述された処理を実行 #-----ここから----- elif (条件式2): # (条件式1)が偽(False)で(条件式2)が真(True)ならここに記述された処理を実行 elif (条件式3): ... else: # 全ての条件式が偽(False)ならここに記述された処理を実行 #-----ここまで----- # 全て省略可能です。つまり最初のifだけでもOK。

for文とwhile文続いてループ処理です。

Pythonのループ処理にはforとwhileの二つがあります。

二つある理由はたまに使い分けたいことがあるからですが、for文をwhile文に、while文をfor文に、等価な処理を行うように変換できますのでお好みで...と言いたいですが、基本的にfor文を使うことを個人的にオススメします。

理由は後ほど...

for文まずは

for文から。

for_sample.py

for_sample.pyfor i in range(10): print(i) print("----------") for i in range(1, 10): print(i, end=" ") if i > 5: print("\n{} > 5".format(i)) print("ループを抜けます") break else: print("この文は出力されません。")さて、上の方の

for文は0〜9まで、縦に並べて出力されます。

下の方は6までが横に並べて出力されて、「6 > 5」「ループを抜けます」と出力されて終わるはずです。

(ついでなのでいくつか紹介していない関数などを使っています。気になった方はググってみましょう。)

for文は文法を見た方がわかりやすいですね。for_grammer_summary.pyfor (変数名) in (配列やリストなど): (繰り返したい処理をここに書く) else: (ループが正常に終了した場合の処理やループが1度も実行されなかった時に行いたい処理をここに書く)

range関数は指定された数までのリストのようなもの4を返します。

break文はループを強制的に抜けるためのものです。

for文では、(配列やリストなど)で指定された数値が順番に(変数名)に代入されて処理が行われます。for_sample.pyの一つ目のループでは

- 変数

iに0が代入される0が出力される- 変数

iに1が代入される1が出力される- ...

のように処理が進みます。

二つ目のループは

for else文の紹介のために書きました。

Pythonでは他の言語には滅多にない、ループ処理にelseを使うことができます。

elseの中には、ループが正常に終了した時に行って欲しい処理を書きます。

つまり、break文でループを強制的に終了した場合はその処理が行われません。

あまり積極的に使うことはありませんが、ネストされたfor文を全て抜けたい時などによりスッキリしたコードを書くことができます。

nested_for.py

nested_for.py# elseあり for i in range(10): for j in range(10): print(i, j) if i * j > 10: # i = 2, j = 6でここに入ります break else: continue break # elseなし flag = False for i in range(10): for j in range(10): print(i, j) if i * j > 10: # i = 2, j = 6でここに入ります flag = True break if flag: break

continue文は以降の処理をスルーして次のループに移るためのものです。

while文次は

while文です。

while_sample.py

while_sample.pyi = 0 while i < 10: print(i) i += 1 print("----------") i = 0 while i < 10: print(i, end=" ") if i > 5: print("\n{} > 5".format(i)) break i += 1 else: print("この文は出力されません")このwhile_sample.pyはそれぞれfor_sample.pyと等価なループ処理となっていることが確認できると思います。

while文の文法は次の通りです。while_grammer_summary.pywhile (条件式): (繰り返したい処理をここに書く) else: (ループが正常に終了した場合の処理やループが1度も実行されなかった時に行いたい処理をここに書く)

while文の特徴は条件式が満たされる限りループ処理をすることですね。

for文では予めループする回数が決まるのに対して、while文は不定なことがあるのが大きな違いです。

これが個人的にwhile文を使わないようにして欲しい理由につながります。while_sample.pyの一つ目のループを以下のように変更して実行すると大量の

0が出力され続けます。

<<注意>>

実行する場合は止め方をよく頭に入れておいてください。while_sample.pyi = 0 while i < 10: print(i) #i += 1<<止め方>>

上部の■をクリックすれば止まります。

jupyter notebookでは簡単な操作で実行を中断できるので便利ですね〜

変数

iの値が変わらないためにいつまでも条件式i < 10が満たされ続けてしまい、処理が無限に行われてしまうためこのようなことが発生します。

このような状況を無限ループと言います。

今回は一生懸命書いたコードがなぜかエラーで動かない!

ではなく

一生懸命書いたコードがエラーもないのに反応しない!という状況になります。

初心者の頃は無限ループなんてそう簡単には気づけないためずーっと頭を悩ませることになりかねません。

以上の理由から、while文でなければ書けないようなループはまずないでしょうから、基本的にfor文を使用するようにしましょう。不連続な関数を描こう

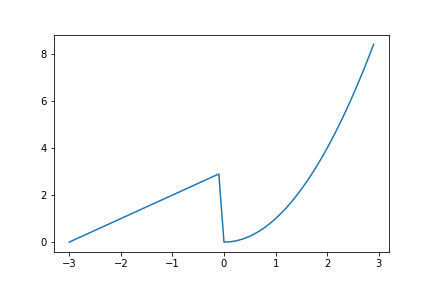

長くなりましたが、条件分岐とループ処理を用いて不連続な関数を書いてみましょう!

graph_plot.pyの関数fの部分を次のように変更しましょう。graph_plot.py# リストを用いたバージョン def f(x): result = [] for i in x: if i < 0: result.append(i + 3) else: result.append(i ** 2) return resultgraph_plot.py# numpy配列を用いたバージョン def f(x): result = np.zeros(len(x)) for i in range(len(x)): if x[i] < 0: result[i] = x[i] + 3 else: result[i] = x[i] ** 2 return resultめんどくさい?

めんどくさいって?間違いない。

ということでスマートな書き方も紹介しておきます。graph_plot.pydef f(x): return np.where(x < 0, x + 3, x ** 2)numpyの

where関数は俗にいう三項演算子というやつです。

詳しくはググりましょう。

ちなみに頑張れば標準の書き方でもそれなりにスマートになります。graph_plot.pydef f(x): return [i + 3 if i < 0 else i ** 2 for i in x]リスト内包表記と

if文の三項演算子を組み合わせたものですね。list_comprehension_grammer.py[(処理) for (変数名) in (配列やリストなど)]ternary_operator_grammer.py(条件式が真の時の処理) if (条件式) else (条件式が偽の時の処理)とはいえ読みにくいし複雑です。

パッケージの偉大さがよくわかります。初めてのPythonシリーズ記事

- 投稿日:2020-05-21T20:40:02+09:00

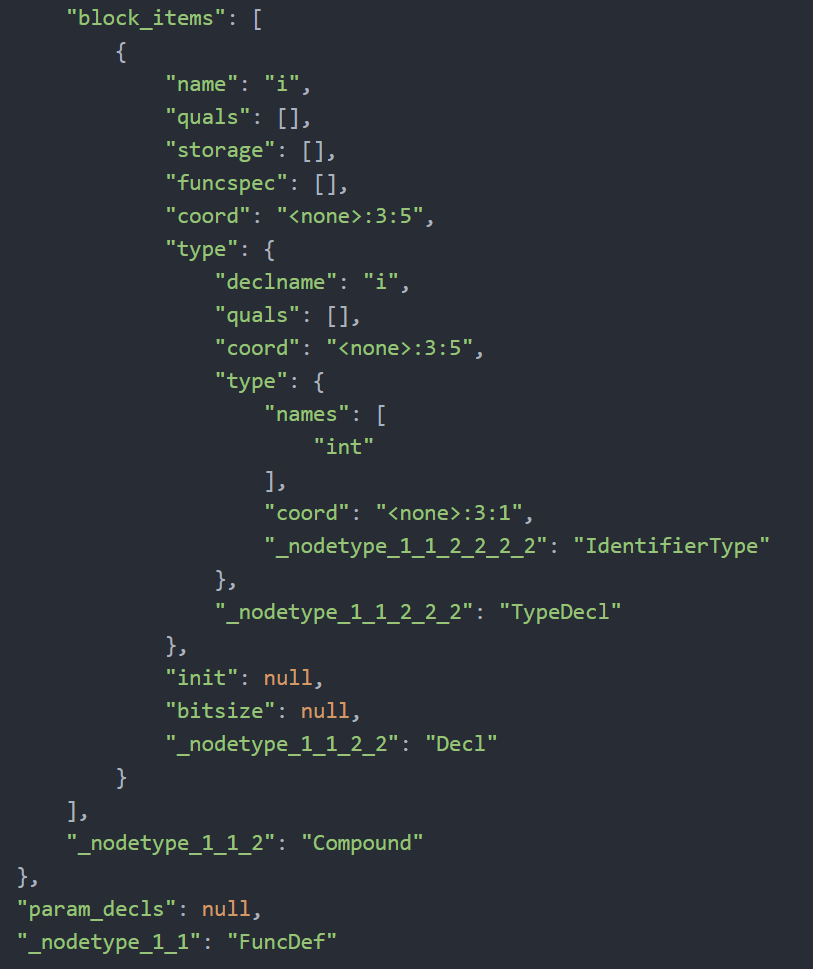

ノードごとのIDを振る

辞書型のASTのキーにルートIDを振っていく。

元ASTは入れ子状態になっているが、ルートIDに該当するものは入力されていない。そのため、元々のキー名+根からのルートをIDを入れたキー名に変更させた。今回は、キー名(_nodetype)のみにルートIDをプラスしました。

その他のキー名にもIDを入れようとしいる状態です。

- 投稿日:2020-05-21T20:28:46+09:00

ゼロから始めるLeetCode Day32「437. Path Sum III」

概要

海外ではエンジニアの面接においてコーディングテストというものが行われるらしく、多くの場合、特定の関数やクラスをお題に沿って実装するという物がメインである。

その対策としてLeetCodeなるサイトで対策を行うようだ。

早い話が本場でも行われているようなコーディングテストに耐えうるようなアルゴリズム力を鍛えるサイト。

せっかくだし人並みのアルゴリズム力くらいは持っておいた方がいいだろうということで不定期に問題を解いてその時に考えたやり方をメモ的に書いていこうかと思います。

前回

ゼロから始めるLeetCode Day30「581. Shortest Unsorted Continuous Subarray」基本的にeasyのacceptanceが高い順から解いていこうかと思います。

Twitterやってます。

そういえば一ヶ月分続きました。めでたい。

問題

437. Path Sum III

難易度はeasy。

Top 100 Liked Questionsのeasyがこれを入れて残り三問となりました。各ノードに整数値が含まれている二分木が与えられます。

ノードの値を合計して特定の値

sumになるパスの数を求めます。経路は親または葉で開始または終了する必要はありませんが、下方向に移動する必要があります(親ノードから子ノードへの移動のみ)。

なお、ツリーのノード数は1,000以下で、値の範囲は-1,000,000〜1,000,000です。

root = [10,5,-3,3,2,null,11,3,-2,null,1], sum = 8

10 / \ 5 -3 / \ \ 3 2 11 / \ \ 3 -2 1Return 3. The paths that sum to 8 are:

- 5 -> 3

- 5 -> 2 -> 1

- -3 -> 11

解法

再帰を使ったdfsで解きました。

# Definition for a binary tree node. # class TreeNode: # def __init__(self, val=0, left=None, right=None): # self.val = val # self.left = left # self.right = right class Solution: ans = 0 def pathSum(self, root: TreeNode, sum: int) -> int: def dfs(root,sums,start): if not root: return 0 sums -= root.val if sums == 0: self.ans += 1 dfs(root.left,sums,False) dfs(root.right,sums,False) if start: dfs(root.left,sum,True) dfs(root.right,sum,True) dfs(root,sum,True) return self.ans # Runtime: 940 ms, faster than 24.67% of Python3 online submissions for Path Sum III. # Memory Usage: 15.1 MB, less than 6.82% of Python3 online submissions for Path Sum III.最初は

rootとsumsだけでかけるかと思って書いていたのですが、どうもそれだけでは書けなかった(書けるかもしれないが今の私の頭では思いつかなかった)ので、discussを覗いたらほとんど一緒の解答があり、そこでは現在のnodeを始点として扱うためにbooleanを用いており、非常にすっきりとした実装ができたのでそのままこちらを載せておきます。それにしてもアルゴリズム強い人すごい・・・

もっと精進しなければならないですね。

良さげな解答があれば追記します。

- 投稿日:2020-05-21T20:22:47+09:00

[Python]04章-01 いろいろなデータ構造(リストの作成と要素の取り出し)

[Python]04章-01 リストの作成と要素の取り出し

この章ではPythonプログラムで扱うデータ構造について述べていきます。

その中で今回はリストについて触れていきたいと思います。オブジェクトとは

Pythonはオブジェクト指向言語と言われています。実は2章で扱った、文字列もオブジェクトというのですが、文字列というモノ(オブジェクト)に対して、動作(メソッド)をしたと思います。

今回扱うリストもオブジェクトの1つです。そういったオブジェクトに対して、また動作もできるようになります。

ただし、オブジェクトは理論的取り扱いが難しいので、詳細はオブジェクト指向の話をした際に詳細を伝えます。

リストの作成

数値リストの作成

Pythonでは関連のあるデータを1つにまとめて表現することができます。これをリスト*と言います。

Python Console より、以下のコードを入力してください。

>>>L = [10, 20, 30, 40, 50]上記のように、リストは[ ]で囲み、「,」で区切って表現します。Lという変数にはリストが代入されています。

以下のようにprint関数で、リストの中身を見ることができます。>>>print(L) [10, 20, 30, 40, 50]最初に「変数」のところでお話ししましたが、値には変数名のタグが付いているとお話ししました。

今回も、リストに対して、タグがつけられていることには変わりはありません。

リストの要素の確認

それぞれの値をリストの要素と言います。例えば、1つの要素を取り出すには、以下のように記載します。今回も文字列の時と同じで、リストの要素番号は0番目から始まります。

また、要素番号には文字列の時と同じで、マイナスの番号も当てることができます。

番号(その1) 0 1 2 3 4 番号(その2) -5 -4 -3 -2 -1 リスト内の数値 10 20 30 40 50 >>>L[2] 30 >>>L[-2] 40なお、もちろん、要素に存在しない番号を指定すると、以下のようにエラーとなります。

>>>L[5] Traceback (most recent call last): File "<input>", line 1, in <module> IndexError: list index out of range文字列のリスト

リストには数値だけでなく、文字列も代入が可能です。ただし、文字列の場合は「'」(シングルクオーテーション)または「"」(ダブルクオーテーション)で囲む必要があります。

Python Console より、以下のコードを入力してください。

>>>strL = ['Japan', 'China', 'Korea'] >>>print(strL) ['Japan', 'China', 'Korea'] >>>strL[1] 'China'strLという変数に、文字列のリストを作成し、要素を指定して出力させています。これは先ほどの数値のリストと同じですね。

リストの取り出し

02章-05でスライスについて説明しました。

リストでもスライスを適用できます。Python Console より、以下のコードを入力してください。lsという変数名にリストを代入して、変数の中身を出力させて確認します。

>>>ls = ['Japan', 'Canada', 'Australia', 'England', 'German', 'Italy', 'France'] >>>print(ls) ['Japan', 'Canada', 'Australia', 'England', 'German', 'Italy', 'France']変数lsの内容を要素番号を付与してまとめると以下のようになります。

番号(その1) 0 1 2 3 4 5 6 番号(その2) -7 -6 -5 -4 -3 -2 -1 リスト内の文字列 'Japan' 'Canada' 'Australia' 'England' 'German' 'Italy' 'France' 上記をもとにスライスを用いて説明していきます。

>>>ls[2:] ['Australia', 'England', 'German', 'Italy', 'France'] >>>ls[:5] ['Japan', 'Canada', 'Australia', 'England', 'German'] >>>ls[2:5] ['Australia', 'England', 'German'] >>>ls[:-3] ['Japan', 'Canada', 'Australia', 'England'] >>>ls[1:-3] ['Canada', 'Australia', 'England']まず、以下の結果について考えていきたいと思います。

>>>ls[2:] >>>ls[:5] >>>ls[2:5]02章-05の文字列のスライスのところでも説明した通り、数学的に考えてみるとわかりやすいかもしれません。ls[2:]については、以下の通りになります。(xについては番号と考えてください)

2≦xつまり、リストの要素番号が2以上の値はすべて出力するということになります。

ls[:3]やls[2:5]についても、それぞれ以下の通りになります。文字列の時と扱いはほぼ同じですね。x<5\\ 2≦x<5次に、以下のスライスを見ていきたいと思います。

>>>ls[:-3] >>>ls[1:-3]これは先ほどの表と組み合わせて考えるとわかりやすいと思います。

「-3」という要素は上の表では'German'ですが、今回は-3の要素番号は含まない、つまりx<-3となるので、上記の表でいうと「-7」「-6」「-5」「-4」(つまり['Japan', 'Canada', 'Australia', 'England'])が該当することになります。

ls[1:-3]についても、表と照らし合わせるとわかりやすいかもしれません。

最後に

今回はデータ構造の中で、リストについて述べました。リストについては今後Pythonでデータ分析を行ったりする際に必ず必要になるので、ぜひ押さえておきましょう。

次回は、リストの操作について述べていきたいと思います。【目次リンク】へ戻る

- 投稿日:2020-05-21T20:22:47+09:00

[Python]04章-01 いろいろなデータ構造(リストの作成と取り出し)

[Python]04章-01 リスト

この章ではPythonプログラムで扱うデータ構造について述べていきます。

その中で今回はリストについて触れていきたいと思います。オブジェクトとは

Pythonはオブジェクト指向言語と言われています。実は2章で扱った、文字列もオブジェクトというのですが、文字列というモノ(オブジェクト)に対して、動作(メソッド)をしたと思います。

今回扱うリストもオブジェクトの1つです。そういったオブジェクトに対して、また動作もできるようになります。

ただし、オブジェクトは理論的取り扱いが難しいので、詳細はオブジェクト指向の話をした際に詳細を伝えます。

リストの作成

数値リストの作成

Pythonでは関連のあるデータを1つにまとめて表現することができます。これをリスト*と言います。

Python Console より、以下のコードを入力してください。

>>>L = [10, 20, 30, 40, 50]上記のように、リストは[ ]で囲み、「,」で区切って表現します。Lという変数にはリストが代入されています。

以下のようにprint関数で、リストの中身を見ることができます。>>>print(L) [10, 20, 30, 40, 50]最初に「変数」のところでお話ししましたが、値には変数名のタグが付いているとお話ししました。

今回も、リストに対して、タグがつけられていることには変わりはありません。

リストの要素の確認

それぞれの値をリストの要素と言います。例えば、1つの要素を取り出すには、以下のように記載します。今回も文字列の時と同じで、リストの要素番号は0番目から始まります。

また、要素番号には文字列の時と同じで、マイナスの番号も当てることができます。

番号(その1) 0 1 2 3 4 番号(その2) -5 -4 -3 -2 -1 リスト内の数値 10 20 30 40 50 >>>L[2] 30 >>>L[-2] 40なお、もちろん、要素に存在しない番号を指定すると、以下のようにエラーとなります。

>>>L[5] Traceback (most recent call last): File "<input>", line 1, in <module> IndexError: list index out of range文字列のリスト

リストには数値だけでなく、文字列も代入が可能です。ただし、文字列の場合は「'」(シングルクオーテーション)または「"」(ダブルクオーテーション)で囲む必要があります。

Python Console より、以下のコードを入力してください。

>>>strL = ['Japan', 'China', 'Korea'] >>>print(strL) ['Japan', 'China', 'Korea'] >>>strL[1] 'China'strLという変数に、文字列のリストを作成し、要素を指定して出力させています。これは先ほどの数値のリストと同じですね。

リストの取り出し

02章-05でスライスについて説明しました。

リストでもスライスを適用できます。Python Console より、以下のコードを入力してください。lsという変数名にリストを代入して、変数の中身を出力させて確認します。

>>>ls = ['Japan', 'Canada', 'Australia', 'England', 'German', 'Italy', 'France'] >>>print(ls) ['Japan', 'Canada', 'Australia', 'England', 'German', 'Italy', 'France']変数lsの内容を要素番号を付与してまとめると以下のようになります。

番号(その1) 0 1 2 3 4 5 6 番号(その2) -7 -6 -5 -4 -3 -2 -1 リスト内の文字列 'Japan' 'Canada' 'Australia' 'England' 'German' 'Italy' 'France' 上記をもとにスライスを用いて説明していきます。

>>>ls[2:] ['Australia', 'England', 'German', 'Italy', 'France'] >>>ls[:5] ['Japan', 'Canada', 'Australia', 'England', 'German'] >>>ls[2:5] ['Australia', 'England', 'German'] >>>ls[:-3] ['Japan', 'Canada', 'Australia', 'England'] >>>ls[1:-3] ['Canada', 'Australia', 'England']まず、以下の結果について考えていきたいと思います。

>>>ls[2:] >>>ls[:5] >>>ls[2:5]02章-05の文字列のスライスのところでも説明した通り、数学的に考えてみるとわかりやすいかもしれません。ls[2:]については、以下の通りになります。(xについては番号と考えてください)

2≦xつまり、リストの要素番号が2以上の値はすべて出力するということになります。

ls[:3]やls[2:5]についても、それぞれ以下の通りになります。文字列の時と扱いはほぼ同じですね。x<5\\ 2≦x<5次に、以下のスライスを見ていきたいと思います。

>>>ls[:-3] >>>ls[1:-3]これは先ほどの表と組み合わせて考えるとわかりやすいと思います。

「-3」という要素は上の表では'German'ですが、今回は-3の要素番号は含まない、つまりx<-3となるので、上記の表でいうと「-7」「-6」「-5」「-4」(つまり['Japan', 'Canada', 'Australia', 'England'])が該当することになります。

ls[1:-3]についても、表と照らし合わせるとわかりやすいかもしれません。

最後に

今回はデータ構造の中で、リストについて述べました。リストについては今後Pythonでデータ分析を行ったりする際に必ず必要になるので、ぜひ押さえておきましょう。

次回は、リストの操作について述べていきたいと思います。【目次リンク】へ戻る

- 投稿日:2020-05-21T19:08:44+09:00

Python: 日本語テキスト:形態素解析

言語処理とテキストコーパス

自然言語処理とは

私たちが普段から話す言葉、書く文章などを

「自然言語」と言い自然言語をコンピュータに処理させる技術を

自然言語処理 (Natural Language Processing, NLP) と呼びます。自然言語処理は、形態素解析や構文解析、意味解析などの要素技術から成り立ちます。

これらの要素技術を複合して、例えば機械翻訳や音声認識、情報検索など、様々な場面で利用されています。自然言語は、本来人間同士が意思疎通を行うために生み出されたものです。

人間は、曖昧な表現を含む言葉が使われていても、それを解釈し意思疎通を図ることができます。

しかし、コンピュータはデータを正確、かつ高速に処理することを得意とするため曖昧な要素が含まれる自然言語を扱うのは苦手です。自然言語処理の例として、日本語のニュース文書をカテゴリーに分類することを考えてみます。

1つの文書に100文字程度の単語が含まれているとして、文書が10程度の量であれば、人間が目を通して手作業で分類することも可能です。しかし、文書が1,000程度の量であれば、コンピュータに処理を任せたくなります。では、コンピュータで自然言語を処理するにはどうすればよいでしょうか。

自然言語をコンピュータが処理しやすい形、つまり数値へ変換すればよいのです。自然言語は単語の集合です。単語を「何らかの方法」で数値データに変換できれば

機械学習やディープラーニングのアルゴリズムで分析が可能になります。この投稿では自然言語を数値データへ変換し

機械学習のアルゴリズムを用いてトピック抽出を行う方法を学びます。雑談対話コーパス

コーパスとは、自然言語の文書を大量に集めたデータです。自然言語は人間同士の意思疎通のための手段であるため

日本語に限らず英語やドイツ語など言語の種類だけ存在します。すべてを紹介することは難しいため、ここでは私たちに馴染みのある日本語コーパスを紹介します。

日本語コーパスは、有償/無償含め多数提供されています。その結果を用いて、文書分類やトピック抽出などを行うことができるのです。

青空文庫 現代日本語書き言葉均衡コーパス(BCCWJ) 雑談対話コーパス 名大会話コーパス(日本語自然会話書き起こしコーパス) 日本語話し言葉コーパス(CSJ) livedoorニュースコーパスこれらのコーパスはCSV形式やJSON形式、XML形式など様々なファイル形式で提供されています。

特に、JSON形式やXML形式は階層構造になっているため

必要なデータを取り出してCSVファイルに変換してから使用することをお薦めします。それではPythonのjsonライブラリを用いて、データの抽出を行ってみます。

データを抽出するには データが格納されている変数名 と 取得したいデータのキー を指定します。# ファイルを読み込み専用モードで読み込みます f = open("./6110_nlp_preprocessing_data/init100/1407219916.log.json", "r", encoding='utf-8') json_data = json.load(f) # `json_data`に含まれる'会話ID('dialogue-id')'を変数`dialogue`に取得します dialogue = json_data["dialogue-id"] print(dialogue) # >>> 出力結果 1407219916使用結果がこちら

import json # ファイルを読み取り専用モードで読み込み f = open("./6110_nlp_preprocessing_data/init100/1407219916.log.json", "r", encoding='utf-8') json_data = json.load(f) # 会話IDの取得 print("dialogue-id : " + json_data["dialogue-id"]) # 話者IDを取得 print("speaker-id : " + json_data["speaker-id"]) # 話者と発話内容を取得 for turn in json_data["turns"]: # 話者のキーは"speaker"、発話内容のキーは"utterance"です print(turn["speaker"] + ":" + turn["utterance"])なおここで使用するコーパスは以下の通りです。

コーパス

雑談対話コーパス

対話システムのエラーを共同で分析することを目的としたデータで、人とシステムの会話(雑談)と、システムの返答すべてにラベルが付いています。ディレクトリ構造

ダウンロードしたデータは init100 と rest1046 のディレクトリに分かれており、init100 には100セットの雑談データ、rest1046 には1,046セットの雑談データが格納されています。その中の init100ディレクトリ のデータを使用します。

ファイル構造

データファイルはJSON形式で提供されており、大きく分けて人の発話(質問)データとシステムの発話(回答)データで構成されています。

1ファイルが1回の対話データです。データ構造

発話データは日本語の文章で表現されており、ファイル内の

'turns'キーの中に格納されています。

'utterance'が発話データで

'speaker'「U」が人、「S」がシステムの発話です。また、システムの発話データには、人の質問に対してシステムの回答が

破綻しているかどうかのフラグ(ラベル)である

'breakdown'やコメント'comment'が付与されています。フラグは

O破綻ではない発話、

T破綻とは言い切れないが違和感のある発話

X明らかにおかしいと感じる発話の3種類です。なお、'breakdown'は複数名のアノテータ('annotator-id')により付されているため

1つのシステムの回答に対し、複数の'breakdown'が存在します。以下にコーパスの一部を示します。

{ 'dialogue-id': '1407219916', 'group-id': 'init100', 'speaker-id': '12_08', 'turns': [ { 'annotations': [ { 'annotator-id': '01_A', 'breakdown': 'O', 'comment': '', 'ungrammatical-sentence': 'O' }, { 'annotator-id': '01_B', 'breakdown': 'O', 'comment': '', 'ungrammatical-sentence': 'O' }, ... { 'annotator-id': '15_A', 'breakdown': 'T', 'comment': 'まったく数値が違う', 'ungrammatical-sentence': 'O' } ], 'speaker': 'S', 'time': '2014-08-05 15:23:07', 'turn-index': 2, 'utterance': '最高気温は17度が予想されます??' }, { 'annotations': [], 'speaker': 'U', 'time': '2014-08-05 15:23:15', 'turn-index': 3, 'utterance': 'いやいや猛暑ですよ' }, ... }分析データの抽出

破綻しにくい発話を定量的に分析していきます。

分析を行うサンプルデータには、init100ディレクトリ内の10ファイルに含まれる

人の発話内容とそれに対するシステムの発話が破綻かどうかのフラグを使用します。分析に必要なデータを取得したら、まずはそこから重複している不要なデータを削除します。

重複データの削除

重複する要素を含む行を削除するにはPandasのdrop_duplicates()メソッドを用います。from pandas import DataFrame # インデックス番号0とインデックス番号2が重複しているDataFrameです df=DataFrame([['AA','Camela',150000,20000], ['BB','Camera',70000,10000], ['AA','Camela',150000,20000], ['AA','Video',3000,150]], columns=['CUSTOMER','PRODUCT','PRICE','DISCOUNT']) df # >>> 出力結果 CUSTOMER PRODUCT PRICE DISCOUNT 0 AA Camela 150000 20000 1 BB Camera 70000 10000 2 AA Camela 150000 20000 3 AA Video 3000 150 # 重複を含む行を削除します drop = df.drop_duplicates() drop # >>> 出力結果 CUSTOMER PRODUCT PRICE DISCOUNT 0 AA Camela 150000 20000 1 BB Camera 70000 10000 3 AA Video 3000 150使用例はこちら

import os import json import pandas as pd # init100ディレクトリを指定 file_path = './6110_nlp_preprocessing_data/init100/' file_dir = os.listdir(file_path) # フラグと発話内容を格納する空のリストを作成 label_text = [] # JSONファイルを1ファイルずつ10ファイル分処理 for file in file_dir[:10]: # 読み込み専用モードで読み込み r = open(file_path + file, 'r', encoding='utf-8') json_data = json.load(r) # 発話データ配列`turns`から発話内容とフラグを抽出 for turn in json_data['turns']: turn_index = turn['turn-index'] # 発話ターンNo speaker = turn['speaker'] # 話者ID utterance = turn['utterance'] # 発話内容 # 先頭行はシステムの発話なので除外 if turn_index != 0: # 人の発話内容を抽出 if speaker == 'U': u_text = '' u_text = utterance else: a = '' for annotate in turn['annotations']: # 破綻かどうかのフラグを抽出 a = annotate['breakdown'] # フラグと人の発話内容をリストに格納 tmp1 = str(a) + '\t' + u_text tmp2 = tmp1.split('\t') label_text.append(tmp2) # リスト`label_text`をDataFrameに変換 df_label_text = pd.DataFrame(label_text) # 重複する行を削除 df_label_text = df_label_text.drop_duplicates() df_label_text.head(25)テキストの形態素解析

形態素解析とは

自然言語処理の手法の一つに

形態素解析 (Morphological Analysis) が上げられます。形態素解析とは、文法ルールや解析辞書データに基づいて文章を単語に分割し

それぞれに品詞を付与する処理です。「形態素」とは、その言語において意味を持つ最小の単位、つまり単語を指します。

ここでは、日本語の形態素解析をみていきます。【テキスト】今日は晴れます。 ↓ 【 形態素 】今日 | は | 晴れ | ます | 。 (名詞)(助詞)(動詞)(助動詞)(記号)形態素と形態素の間は、分かりやすいように「|」で区切りました。

例に挙げたような短文であれば、人手で文章を単語に分割することも可能ですが

実際に扱う文書に含まれる文章は長文ですので、コンピュータで処理を行うのが現実的です。コンピュータで形態素解析を実行するツールに形態素解析エンジンと呼ばれるものがあります。

形態素解析エンジンはインストールして実行するもの

Web APIとして呼び出せるもの

プログラミング言語のライブラリとして呼び出せるものなど

有償/無償含めて様々な形で提供されています。これらの主な違いは、形態素解析に使用する文法や辞書の違いです。ChaSen :奈良先端科学技術大学院大学 松本研究室が開発・提供。 JUMAN :京都大学 黒橋・河原研究室が開発・提供。 MeCab :工藤拓氏が開発・オープンソースとして提供。 Janome :打田智子氏が開発・Pythonライブラリとして提供。 Rosette Base Linguistics :ベイシステクノロジー社が開発・提供(有償)。MeCabを使った形態素解析と分かち書き

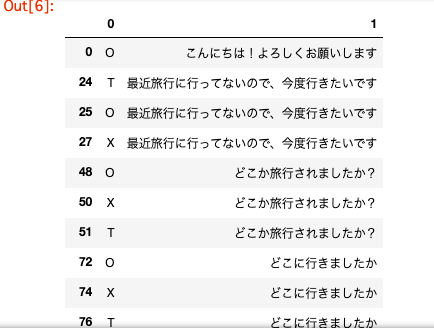

形態素解析エンジンMeCabを用いて日本語テキストの形態素解析と分かち書きを行ってみます。

形態素解析 ①Tagger()オブジェクトを用い、引数の出力モードに形態素の分割に使用する辞書を指定します。 ②何も指定しない場合は、MeCabの標準システム辞書を使用します。 ③parse('文字列')で指定した文字列を形態素に分割し、品詞などを付与した形態素解析結果を取得します。import MeCab k = MeCab.Tagger() print(k.parse('形態素解析したい言葉'))出力結果 形態素 名詞,一般,*,*,*,*,形態素,ケイタイソ,ケイタイソ 解析 名詞,サ変接続,*,*,*,*,解析,カイセキ,カイセキ し 動詞,自立,*,*,サ変・スル,連用形,する,シ,シ たい 助動詞,*,*,*,特殊・タイ,基本形,たい,タイ,タイ 言葉 名詞,一般,*,*,*,*,言葉,コトバ,コトバ EOS出力される形態素解析の結果は左から順に以下の通りです。

なお、()内の表記は、それぞれの属性の情報を取得する際の属性名です。表層形(surface)(文章中で使用されている単語) 品詞(part_of_speech) 品詞細分類1〜3(part_of_speech) 活用型(infl_type) 活用形(infl_form) 原形(base_form)(文章中で使用されている単語の原形) 読み(reading) 発音(phonetic)分かち書き

Tagger()オブジェクトの出力モードに('-Owakati')を指定すると

品詞などを付与せず、形態素ごとに区切りの空白を入れる分かち書きのみを行うことができます。import MeCab k = MeCab.Tagger('-Owakati') print(k.parse('分かち書きしたい言葉'))>>> 出力結果 分かち書き し たい 言葉その他の出力モード -Oyomi : 読みのみを出力 -Ochasen : ChaSen 互換形式 -Odump : すべての情報を出力使用例はこちら

import MeCab # 形態素解析 m = MeCab.Tagger() print(m.parse('すもももももももものうち')) # 分かち書き w = MeCab.Tagger('-Owakati') print(w.parse('すもももももももものうち'))Janomeを使った形態素解析と分かち書き

続いて、形態素解析エンジンJanomeを用いて日本語テキストの形態素解析と分かち書きを行います。

形態素解析 ①Tokenizer()オブジェクトを作成し、tokenize()メソッドに形態素解析したい文字列を指定します。 ②形態素解析の出力結果の読み方はMeCabと同様です。from janome.tokenizer import Tokenizer # Tokenizerオブジェクトの生成 t = Tokenizer() tokens = t.tokenize("形態素解析したい言葉") for token in tokens: print(token)>>> 出力結果 形態素 名詞,一般,*,*,*,*,形態素,ケイタイソ,ケイタイソ 解析 名詞,サ変接続,*,*,*,*,解析,カイセキ,カイセキ し 動詞,自立,*,*,サ変・スル,連用形,する,シ,シ たい 助動詞,*,*,*,特殊・タイ,基本形,たい,タイ,タイ 言葉 名詞,一般,*,*,*,*,言葉,コトバ,コトバ分かち書き

tokenize()メソッドの引数にwakati=True を指定すると、分かち書きのみを行います。from janome.tokenizer import Tokenizer # Tokenizerオブジェクトの生成 t = Tokenizer() tokens = t.tokenize("分かち書きしたい言葉", wakati=True) for token in tokens: print(token)>>> 出力結果 分かち書き し たい 言葉その他機能

①品詞でフィルターをかけることができます。

除外したい場合は、除外したい品詞を指定します。 POSStopFilter(['接続詞', '記号', '助詞', '助動詞']) 取得したい場合は、取得したい品詞を指定します。 POSKeepFilter(['名詞'])②Analyzerは、形態素解析の前処理・後処理をテンプレート化するためのフレームワークです。

Analyzer(前処理, Tokenizerオブジェクト, フィルター) を渡します。

前処理の部分は以下のように設定します。char_filters = [UnicodeNormalizeCharFilter(), RegexReplaceCharFilter('正規表現', '変換したい文字')]UnicodeNormalizeCharFilter() Unicode文字列の表記揺れを正規化します。 引数は"NFKC"、"NFC"、"NFKD"、"NFD"のいずれかで、デフォルトはNFKCです。 例えば、全角の"ABC"は半角の"ABC"へ、半角の"カナ"は全角の"カナ"へなどの正規化を行います。 RegexReplaceCharFilter('正規表現', '変換したい文字') 正規表現パターンにマッチした文字列を置換します。from janome.tokenizer import Tokenizer from janome.tokenfilter import POSKeepFilter from janome.analyzer import Analyzer # Tokenizerオブジェクトの生成 t = Tokenizer() # 名詞のみを抽出するフィルターを生成 token_filters = [POSKeepFilter(['名詞'])] # フィルターを搭載した解析フレームワークの生成 analyzer = Analyzer([], t, token_filters) # 実行 for token in analyzer.analyze("フィルターをかけたい言葉"): print(token)>>> 出力結果 フィルター 名詞,一般,*,*,*,*,フィルター,フィルター,フィルター 言葉 名詞,一般,*,*,*,*,言葉,コトバ,コトバ使用例はこちら

from janome.tokenizer import Tokenizer from janome.tokenfilter import POSKeepFilter from janome.analyzer import Analyzer # 形態素解析オブジェクトの生成 t = Tokenizer() # 名詞のみ抽出するフィルターを生成 token_filters = [POSKeepFilter(['名詞'])] # フィルターを搭載した解析フレームワークの生成 analyzer = Analyzer([], t, token_filters) for token in analyzer.analyze('すもももももももものうち'): print(token)テキストの正規化

形態素解析に使用される辞書

形態素解析の 解析結果は辞書に依存しており

実行時は標準で備わっている「標準辞書」を使用して文章を単語へ分割し品詞を付与します。標準辞書には一般的な単語は収録されていますが

専門用語が含まれていたり、新語がアップデートされることは多くありません。このような場合、単語が不自然に分割されたり、品詞が未知語と解析されたりします。

【テキスト】私は東京タワーに行きます。 【解析結果】私 | は | 東京 | タワー | に | 行き | ます | 。これを防ぐには、標準辞書とは別にユーザー辞書を用意します。

ユーザー辞書の作成方法は、形態素解析エンジンによって異なるので

ここではユーザー辞書の存在のみ覚えておいてください。なお、無償で配布しているユーザー辞書もあるので目的に合わせて検索し

インストールしても良いかもしれません。(ただし、自己の判断と責任で利用するものとします。)テキストの正規化

形態素解析を実行する前に 不要な記号を削除 したり 表記を統一 するなど、表記揺れを 正規化する 作業を行います。

【テキスト】私は昨日,りんごを食べました。今日は、林檎ジュースを飲みます。 【正規化後】私は昨日、りんごを食べました。今日は、りんごジュースを飲みます。上記の例では、句点は「,」と「、」の2種類ありますが、意味は同じなので「、」に統一できます。

また、単語「りんご」と「林檎」も同様に統一できます。コンピュータで正規化を行う際、文字列の指定には 正規表現 (regular expression) を用います。

正規表現 (regular expression) とは、いくつかの文字列を一つの形式で表現することです。例えば、テキストに含まれるある文字列を検索するには、検索対象の文字列を次のように文字種で表します。[0-9] : 数字0~9の中の どれか1文字にマッチする [0-9a-z]+ : 数字0~9、英小文字a~zの中の 1文字以上にマッチするテキストに含まれるある文字列を取り除きたいときや置き換えを行う場合

re.sub()を用いますが、引数の取り除きたい文字列をこの正規表現で指定します。import re re.sub("取り除きたい文字列", "変換後の文字列", "取り除きたいテキスト")使用例はこちら

import re # 英数字を除外したテキストを出力 re.sub("[0-9a-zA-Z]+", "", "私は商品Aを10個買います。")

- 投稿日:2020-05-21T19:03:00+09:00

100日後にエンジニアになるキミ - 62日目 - プログラミング - 暗号について

昨日までのはこちら

100日後にエンジニアになるキミ - 59日目 - プログラミング - アルゴリズムについて

100日後にエンジニアになるキミ - 53日目 - Git - Gitについて

100日後にエンジニアになるキミ - 42日目 - クラウド - クラウドサービスについて

100日後にエンジニアになるキミ - 36日目 - データベース - データベースについて

100日後にエンジニアになるキミ - 24日目 - Python - Python言語の基礎1

100日後にエンジニアになるキミ - 18日目 - Javascript - JavaScriptの基礎1

100日後にエンジニアになるキミ - 14日目 - CSS - CSSの基礎1

100日後にエンジニアになるキミ - 6日目 - HTML - HTMLの基礎1

暗号について

暗号とは何でしょうか?

暗号は第三者が見ても特別な知識なしでは読めないように変換する手法のことを言います。初期の古典暗号は、多くは紙と鉛筆のみで暗号化を行いますが、多少の道具を用いていました。

種類としては

古典暗号

暗号の作り方も鍵も秘密のアルゴリズムのみで数学的な安全性評価なし

換字式暗号

転置式暗号

スキュタレー暗号

シーザー暗号現代暗号

暗号アルゴリズムは公開され、鍵のみが秘密

暗号・復号のアルゴリズムは公開されているためプログラムとして実装可能

暗号の安全性は計算量を基に議論する共通鍵暗号系:

DES暗号,AES暗号

公開鍵暗号系:RSA暗号,ElGamal暗号こんな感じです。

暗号関連用語

以下に暗号で使われる用語を解説する

以下に暗号で使われる用語を解説します。

用語 説明 平文 (plaintext) 暗号化される前の文。 暗号文 (ciphertext) 平文を、独特の表記法によって第三者が読み解けないようにした通信文。 鍵 (key) 表記法のパラメータ。鍵が異なると平文が同じでも暗号文が異なる。 セキュリティパラメータ (security parameter) 暗号の安全性を表す尺度。鍵のサイズなどを指定する。 暗号化 (encryption; encode, encipher) 表記法に従って平文を暗号文に変換すること。 復号 (decryption; decode, decipher) 表記法に従って暗号文を平文に戻すこと。 攻撃 (attack) 暗号化に用いられた表記法の特定あるいは鍵を探索する行為。解読ともいう。 暗号解読 (cryptanalysis) 受信者以外の第三者が暗号文を通信文に戻そうとすること。 共通鍵 (common key; symmetric key) 共通鍵暗号において、暗号化にも復号にも用いられる鍵。秘密鍵ということもある。 公開鍵 (public key) 公開鍵暗号において、暗号化に使用する鍵。 秘密鍵 (private key) 公開鍵暗号において、復号に使用する鍵。 シーザー暗号(Caesar cipher)

「お前もか!!」で有名なシーザーさんの使っていた暗号だそうです。

方式は文字をシフトさせるだけのお手軽暗号化です。

鍵は何文字、という部分だけで特に秘密なものはありません

頑張れば読めてしまうであろう暗号ですね。

それでも昔は暗号として使えていたというわけです。実際にプログラムで暗号文を作ってみましょう。

英文字のみをシフトさせるとし

何文字シフトさせるかは可変にしています。def caesar_cipher_encrypt(plaintext, key): cipher = "" for p in list(plaintext): if 'A' <= p <= 'Z': cipher += chr((ord(p) - ord('A') + key)%26 + ord('A')) elif 'a' <= p <= 'z': cipher += chr((ord(p) - ord('a') + key)%26 + ord('a')) else: cipher += p return cipherこれで暗号化させる関数は出来上がりです、

復号もこれで行う事ができます。これで暗号化された文字を解読してみましょう。

zdwdvklqr jhvvbxxkd 53pdq ghdwktext = 'zdwdvklqr jhvvbxxkd 53pdq ghdwk' for i in range(1,26): print(i,caesar_cipher_encrypt(text, i))1 aexewlmrs kiwwcyyle 53qer hiexl

2 bfyfxmnst ljxxdzzmf 53rfs ijfym

3 cgzgynotu mkyyeaang 53sgt jkgzn

・・・23 watashino gessyuuha 53man death

これですね!!

23文字シフトさせたやつが答えっぽいです。スキュタレー暗号

スキュタレー暗号は棒に革紐を巻きつけて平文を書いて

革紐を外したら、それが暗号になるというものです。元の文字自体は変わらず文字の順番のみが変わるというものです。

このような関数でスキュタレー暗号を作ることができます。

def sq_cipher_encrypt(plaintext, num): cipher = "" c,b = 0,0 for i in range(len(plaintext)): cipher += plaintext[c] if c+num<len(plaintext): c+=num else: b+=1 c=b return ciphersq_cipher_encrypt('私の戦闘力は53マンです',4)'私力マのはン戦5で闘3す'

sq_cipher_encrypt('私力マのはン戦5で闘3す',3)'私の戦闘力は53マンです'

同じ棒がなかったら昔は解読できなかったとか言われているそうで

何事も暗号も辛抱(芯棒)が大事お後がよろしいようでwww

ヴィジュネル暗号

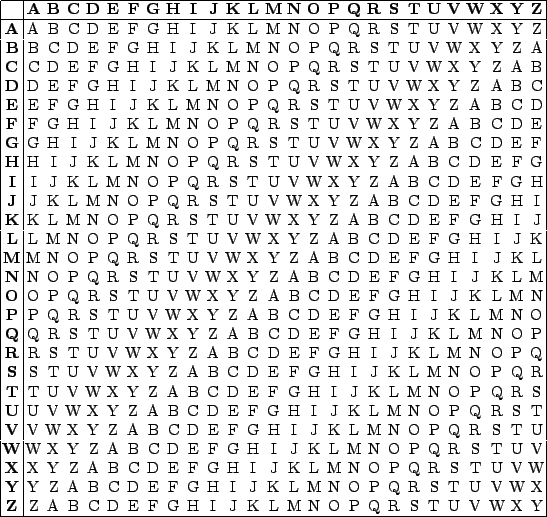

ヴィジュネル暗号は15~16世紀に考えられた換字式の暗号です。下記のヴィジュネル方陣と鍵を使って暗号化を行います。

例として鍵:

arm、平文:CODEとするとヴィジュネル方陣で

aとCの交わりはc,rとOはf,mとDはpというように

暗号文c, f, pが得られる。平文が鍵よりも長い場合、鍵を繰り返して用い最後の平文

Eはaとの交わりでeとなり、平文:CODEは暗号文:cfpeとなる。1文字づつシフトする文字が変わるため、鍵がないと複合が難しくなる。

参考:wikipedia

相当長い暗号文が与えられしかもそれがヴィジュネル暗号だと分かっているときは

頑張れば解読可能だったりします。# 暗号化 def encrypt( plain, key ): index , result = 0 , '' while index < len(plain): index2 = index % len(key) p_code = ord(plain[index]) - ord('a') k_code = ord(key[index2]) - ord('A') result += chr( (p_code + k_code) % 26 + ord('a') ) index += 1 return result # 復号化 def decrypt( cipher, key ): index , result = 0 , '' while index < len(cipher): index2 = index % len(key) c_code = ord(cipher[index]) - ord('a') k_code = ord(key[index2]) - ord('A') result += chr((c_code - k_code) % 26 + ord('a') ) index += 1 return result # 暗号化する文字の指定 plain_text = 'otexintexin birooon' # キーの指定 key_text = 'otupy' # 暗号化 cipher_text = encrypt( plain_text , key_text ) print( cipher_text ) # 復号化 decode_text = decrypt( cipher_text , key_text ) print( decode_text )isesmhsesmhaimsinn

otexintexinbirooonエニグマ(Enigma)

エニグマは人類史上最も有名な暗号だと思います。

第二次世界大戦でナチス・ドイツが用いたローター式暗号機で幾つかの型があり

暗号機によって作成される暗号も広義にはエニグマと呼ばれるようです。そもそも名前がかっこいい!!!

仕組みを説明すると死んでしまうのでこちらを参照ください。

こんなコードでエニグマを再現できるっぽいです。

import random import copy class Enigma: def __init__(self, s1, s2 = 0, s3 = 0): alpha = [chr(i) for i in range(ord("a"), ord("z") + 1)] adds = [' ', '?', '.', ','] self.orig = alpha+ adds self.c_num = len(self.orig) self.c_num2 = self.c_num * self.c_num self.rotor1 = self.make_rotor(s1) self.rotor2 = self.make_rotor(s2) self.rotor3 = self.make_rotor(s3) self.reflect = self.make_rotor(s1) self.plug = self.make_plug() def make_rotor(self, seed = 0): random.seed(seed) alpha = copy.copy(self.orig) random.shuffle(alpha) return alpha def make_plug(self, seed = 0): random.seed(seed) plug = copy.copy(self.orig) rp = random.sample(range(self.c_num), 6) for idx in range(0, 6, 2): plug[rp[idx]] , plug[rp[idx + 1]] = (plug[rp[idx + 1]] , plug[rp[idx]],) return plug def rotate(self, idx): self.rotor1.append(self.rotor1.pop(0)) if idx % self.c_num == 0 and idx / self.c_num != 0: self.rotor2.append(self.rotor2.pop(0)) if idx % self.c_num2 == 0 and idx / self.c_num2 != 0: self.rotor3.append(self.rotor3.pop(0)) def encode_c(self, ch): char = self.plug[self.orig.index(ch)] char = self.rotor1[self.orig.index(char)] char = self.rotor2[self.orig.index(char)] char = self.rotor3[self.orig.index(char)] if self.reflect.index(char) % 2 == 0: char = self.reflect[self.reflect.index(char) + 1] else: char = self.reflect[self.reflect.index(char) - 1] char = self.orig[self.rotor3.index(char)] char = self.orig[self.rotor2.index(char)] char = self.orig[self.rotor1.index(char)] char = self.orig[self.plug.index(char)] return char def encode(self, string): code_string = "" for idx, char in enumerate(string): code_string += self.encode_c(char) self.rotate(idx) return code_string# シードを設定 seed = 1 # 平文を設定 plain = 'hirabunoyabun' # 暗号化 enigma = Enigma(seed) enc = enigma.encode(plain) print("Encrypt : " , 'Seed : ' , seed , enc) # 復号化 enigma = Enigma(seed) dec = enigma.encode(enc) print("Decrypt : ", 'Seed : ' , seed , dec ) # 復号化(シード違い) seed2 = 2 enigma = Enigma(seed2) dec = enigma.encode(enc) print("Decrypt : ", 'Seed : ' , seed2 , dec )Encrypt : Seed : 1 adjpiqisrgxgp

Decrypt : Seed : 1 hirabunoyabun

Decrypt : Seed : 2 vssxdz,rqyhwqシードが分かってないと復号は大変です。

RSA暗号

RSA暗号は桁数が大きい合成数の素因数分解問題が困難であることを

安全性の根拠とした公開鍵暗号の一つです。現在、公開鍵暗号アルゴリズムの中では広く使われています。

仕組み

RSA暗号は

1.鍵生成アルゴリズム(公開鍵と秘密鍵の生成) 2.暗号化アルゴリズム(公開鍵による暗号化) 3.復号アルゴリズム(秘密鍵による複合)からなります。

鍵の生成には2つの素数P,Qを用いて 数値nを作ります。

この時に用いる素数の桁数(長さ)が暗号の強度になります。

n = p * q例:p,q (3,5) として

n = p * q = 3 * 5 = 15次に

φ(n)=(p-1)(q-1)を求める

(自然数nに関してnと互いに素なn未満の自然数の個数をφ(n)とする)例:

φ(n) = (3-1)(5-1) = 8公開鍵は

(e , n)となりますがeは(p - 1)(q - 1)未満かつ

(p - 1)(q - 1)と互いに素な数から適当に選べば良いようです。今回は

3とすることとします。そうすると 公開鍵は

(e, n) = (3, 15)となります。秘密鍵

dはd * e = l(modφ(n))を解くことで求められます。

今回は 秘密鍵d = 3とします。暗号化と復号化

暗号化(平文 m から暗号文 c を作成する):

c = ?? mod n

復号 (暗号文 c から元の平文 m を得る):m = ?? mod n平文

m = 3の場合(上記でn = 15,e = 3,d = 3)暗号化 :

c = 33 mod 15 = 27 mod 15 = 12

復号 :m = 123 mod 15 = 1728 mod 15 = 3RSAでは2048bit以上の大きさの鍵であれば安全であると言われていますが