- 投稿日:2020-03-24T23:55:25+09:00

Dockerで構築するEthereum PET-SHOP TRUFFLE BOXES(その1)

TruffleBoxs 入門(以下「入門記事」)

では、下記サイト(以下「React&Truffle記事」)をなぞらせていただきました。

TruffleBox (React&Truffle)を用いたDockerでのdapps(ブロックチェーンアプリ)の開発環境の構築本記事では、より実践的なチュートリアルに挑戦ということで、ペットショップをやってみたいと思います。

ETHEREUM PET SHOP -- YOUR FIRST DAPP

ちなみに、このチュートリアルとはどのようなものなのか、今話題のDeepLで翻訳すると、このようになりました。

このチュートリアルでは、ペットショップのための養子縁組追跡システムを作成するプロセスを説明します。

このチュートリアルは、Ethereumとスマートコントラクトの基本的な知識があり、HTMLとJavaScriptの知識はあるが、ダップスには初めての方を対象としています。

開発環境構築

Docker環境

React&Truffle記事を参考に、使用するTruffleBox をペットショップに変更する形でDocker環境を用意します。

docker-compose.ymlversion: '3' services: truffle: build: context: ./trufflebox/ dockerfile: Dockerfile volumes: - ./trufflebox:/usr/src/app command: sh -c "cd client && yarn start" ports: - "8003:3000"DockerfileFROM node:8-alpine RUN apk add --update alpine-sdk RUN apk add --no-cache git python g++ make \ && npm i -g --unsafe-perm=true --allow-root truffle WORKDIR /usr/src/appこの2ファイルを下記構成で作成。

pet-shop ├── docker-compose.yml └── trufflebox └── Dockerfilepet-shopフォルダで、下記を実行。

$ docker-compose build Building truffle Step 1/4 : FROM node:8-alpine ---> 2b8fcdc6230a Step 2/4 : RUN apk add --update alpine-sdk ---> Using cache ---> 761342077e72 Step 3/4 : RUN apk add --no-cache git python g++ make && npm i -g --unsafe-perm=true --allow-root truffle ---> Using cache ---> 82200b1b0c8f Step 4/4 : WORKDIR /usr/src/app ---> Using cache ---> 4eb121f5853d Successfully built 4eb121f5853d Successfully tagged pet-shop_truffle:latest$ docker-compose run truffle truffle unbox pet-shop Creating network "pet-shop_default" with the default driver You can improve web3's peformance when running Node.js versions older than 10.5.0 by installing the (deprecated) scrypt package in your project This directory is non-empty... ? Proceed anyway? (Y/n) Starting unbox... ================= ? Proceed anyway? Yes ✔ Preparing to download box ✔ Downloading npm WARN pet-shop@1.0.0 No description npm WARN pet-shop@1.0.0 No repository field. npm WARN optional SKIPPING OPTIONAL DEPENDENCY: fsevents@1.2.4 (node_modules/fsevents): npm WARN notsup SKIPPING OPTIONAL DEPENDENCY: Unsupported platform for fsevents@1.2.4: wanted {"os":"darwin","arch":"any"} (current: {"os":"linux","arch":"x64"}) ✔ cleaning up temporary files ✔ Setting up box Unbox successful, sweet! Commands: Compile: truffle compile Migrate: truffle migrate Test contracts: truffle test Run dev server: npm run devReact&Truffle記事では、「unbox react」としていたところを、今回は、「unbox pet-shop」とするわけです。

これにより、

https://www.trufflesuite.com/boxes/pet-shop

を使用していることになります。Ethereum ネットワーク

React&Truffle記事を参考に、Docke環境からローカルのGanache のテストネットワークに接続します。

まず、ローカル環境に接続可能なIPアドレスを割り振ります。

ローカルIPアドレスない場合は設定します。(React&Truffle記事、及び、入門記事参照)

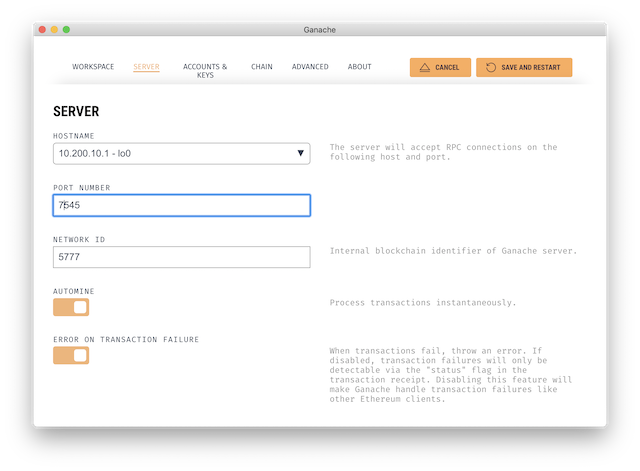

そして、Ganache の設定画面で、ローカルIPアドレスで起動するように指定します。

PORT NUMBER は7545としておきます。これは後で出てきます。この状態で、METAMASKで接続できることを確認しておきます。

METAMASKは、このアドレス、ポートで接続するための設定を追加します。

ここに接続するように、truffle-config.jsを構成します。

先ほど実行された、unbox pet-shop により、trufflebox フォルダに、ファイルが作成されています。自動作成されたtruffle-config.js は下記のようになっていました。

truffle-config.js(自動作成)module.exports = { // See <http://truffleframework.com/docs/advanced/configuration> // for more about customizing your Truffle configuration! networks: { development: { host: "127.0.0.1", port: 7545, network_id: "*" // Match any network id }, develop: { port: 8545 } } };truffleは、ネットワーク名を指定しなければ、development を使用します。

ですので、この中の設定を変更します。truffle-config.js(変更)module.exports = { // See <http://truffleframework.com/docs/advanced/configuration> // for more about customizing your Truffle configuration! networks: { development: { host: "10.200.10.1", port: 7545, network_id: "*" // Match any network id }, develop: { port: 8545 } } };そして、マイグレート=Ganache へのデプロイ。

$ docker-compose run truffle truffle migrate You can improve web3's peformance when running Node.js versions older than 10.5.0 by installing the (deprecated) scrypt package in your project Compiling your contracts... =========================== > Everything is up to date, there is nothing to compile. Starting migrations... ====================== > Network name: 'development' > Network id: 5777 > Block gas limit: 0x6691b7 1_initial_migration.js ====================== Deploying 'Migrations' ---------------------- > transaction hash: 0xd032d73ed143eeb44062f09d02fa64888d9c133d3addb2ff79ccef63d7a4f1ff > Blocks: 0 Seconds: 0 > contract address: 0xF88b3D9805da39D094178f2ba0dCc38a0610d214 > block number: 5 > block timestamp: 1585053865 > account: 0xc55F3d6C444ca88f529F3413EDEd85a39e38609C > balance: 99.98893326 > gas used: 188483 > gas price: 20 gwei > value sent: 0 ETH > total cost: 0.00376966 ETH > Saving migration to chain. > Saving artifacts ------------------------------------- > Total cost: 0.00376966 ETH Summary ======= > Total deployments: 1 > Final cost: 0.00376966 ETH起動。

$ docker-compose up Creating pet-shop_truffle_1 ... done Attaching to pet-shop_truffle_1 truffle_1 | sh: cd: line 1: can't cd to client: No such file or directory pet-shop_truffle_1 exited with code 2おっと失敗。フォルダ構成違うんですね。

docker-compose.ymlのcommandを修正します。docker-compose.ymlversion: '3' services: truffle: build: context: ./trufflebox/ dockerfile: Dockerfile volumes: - ./trufflebox:/usr/src/app command: sh -c "npm run dev" ports: - "8003:3000"$ docker-compose up Recreating pet-shop_truffle_1 ... done Attaching to pet-shop_truffle_1 truffle_1 | truffle_1 | > pet-shop@1.0.0 dev /usr/src/app truffle_1 | > lite-server truffle_1 | truffle_1 | ** browser-sync config ** truffle_1 | { injectChanges: false, truffle_1 | files: [ './**/*.{html,htm,css,js}' ], truffle_1 | watchOptions: { ignored: 'node_modules' }, truffle_1 | server: truffle_1 | { baseDir: [ './src', './build/contracts' ], truffle_1 | middleware: [ [Function], [Function] ] } } truffle_1 | [Browsersync] Access URLs: truffle_1 | ----------------------------------- truffle_1 | Local: http://localhost:3000 truffle_1 | External: http://172.22.0.2:3000 truffle_1 | ----------------------------------- truffle_1 | UI: http://localhost:3001 truffle_1 | UI External: http://localhost:3001 truffle_1 | ----------------------------------- truffle_1 | [Browsersync] Serving files from: ./src truffle_1 | [Browsersync] Serving files from: ./build/contracts truffle_1 | [Browsersync] Watching files... truffle_1 | [Browsersync] Couldn't open browser (if you are using BrowserSync in a headless environment, you might want to set the open option to false)ブラウザで、

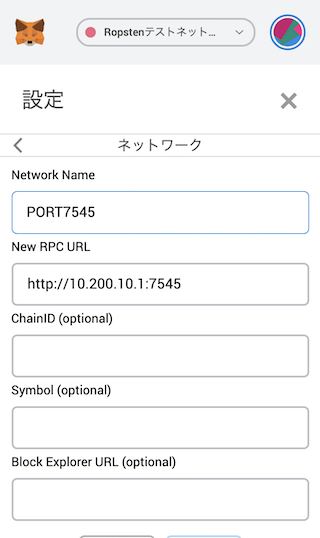

http://localhost:8003/

を開きます。画面が開きます!これにより、PET-SHOPトリュフボックスのInstallationがDocker環境にできたことになりまし、ETHEREUM PET SHOP -- YOUR FIRST DAPPのWriting the smart contract を始められる環境になったことになります。

いったんここで終了し、次の記事で、スマートコントラクトを作成していきます。

- 投稿日:2020-03-24T23:27:36+09:00

Docker勉強メモ④-コンテナ間通信

はじめに

Docker勉強メモ

- Docker勉強メモ① DockerインストールからHelloWorld

- Docker勉強メモ② Dockerイメージ作ってみる

- Docker勉強メモ③ Dockerfileを作ってDockerイメージ作成からコンテナ起動までやってみる

- Docker勉強メモ④-コンテナ間通信 ←ココやること

コンテナ間通信やってみる。

コンテナ間通信をする方法は2つ

- Dockerネットワークを作成してコンテナ名で接続できるようにする

- 「--link」オプションを使用する「--link」オプションは、レガシーで削除の可能性あり、なので本記事ではスルー

豆知識

Docker のインストールは、自動的に3つのネットワークを作成

ネットワーク確認 :docker network ls

docker0 と表示されるブリッジ( bridge )ネットワーク

docker run --net=<ネットワーク名> と指定しないとdocker0になる

docker0情報は、ホストでifconfigで確認できるコンテナ間通信 : Dockerネットワーク

Dockerネットワーク(bridgeタイプ)を作成

ホスト$ docker network create wordpress-networkネットワークを指定してコンテナを起動する

ホスト$ docker run --name mysql --network wordpress-network -e MYSQL_ROOT_PASSWORD=my-secret-pw -d mysql:5.7 $ docker run --name wordpress --network wordpress-network -e WORDPRESS_DB_PASSWORD=my-secret-pw -p 8080:80 -d wordpress・DBとWebサーバのコンテナを作る

・同じネットワークwordpress-networkを指定する

・MySQLのコンテナ名は「mysql」とする

↑WordPressのDockerイメージは、MySQLへの接続先の指定のホスト名が「mysql」だから

→これで、WordPressコンテナ(wordpress)からMySQLコンテナ(mysql)に向けて通信可になるポート指定の注意点

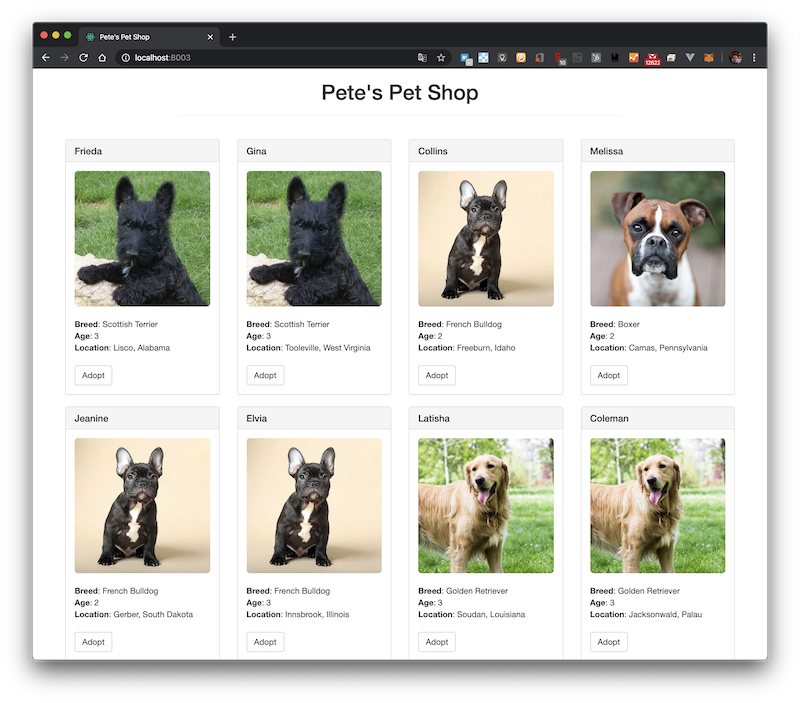

ホスト$ docker run --name mysql --network wordpress-network -p 13306:3306 -e MYSQL_ROOT_PASSWORD=my-secret-pw -d mysql:5.7図にするとこんな感じのはず

Dockerイメージを用いてコンテナ間で通信

次は、こんなの作ってみる

※Dockerイメージを用いてコンテナ間で通信するためには、定義ファイルなどに接続先としてコンテナ名を指定しておくことが必要

[centos@ip-172-31-0-62 ~]$ mkdir nginx [centos@ip-172-31-0-62 ~]$ touch nginx/Dockerfile [centos@ip-172-31-0-62 ~]$ mkdir nginx/files [centos@ip-172-31-0-62 ~]$ touch nginx/files/tomcat.conf [centos@ip-172-31-0-62 ~]$ mkdir tomcat [centos@ip-172-31-0-62 ~]$ touch tomcat/Dockerfile [centos@ip-172-31-0-62 ~]$ mkdir tomcat/files [centos@ip-172-31-0-62 ~]$ cd tomcat/files [centos@ip-172-31-0-62 ~]$ wget http://ftp.riken.jp/net/apache/tomcat/tomcat-9/v9.0.31/bin/apache-tomcat-9.0.31.tar.gznginx/DockerfileFROM nginx:latest RUN rm -f /etc/nginx/conf.d/default.conf COPY ./files/tomcat.conf /etc/nginx/conf.d/nginx/files/tomcat.confserver { location /tomcat/ { proxy_pass http://tomcat-1:8080/; } }tomcat/DockerfileFROM centos:latest RUN yum install -y java ADD files/apache-tomcat-9.0.31.tar.gz /opt/ CMD [ "/opt/apache-tomcat-9.0.31/bin/catalina.sh", "run" ]ホスト[centos@ip-172-31-0-62 ~]$ tree . ├── nginx │ ├── Dockerfile │ └── files │ └── tomcat.conf └── tomcat ├── Dockerfile └── files └── apache-tomcat-9.0.31.tar.gzNginxイメージ、Tomcatイメージの作成

ホスト$ cd ${SOME_DIR}/nginx $ docker build -t nginx-tomcat:1 . $ cd ${SOME_DIR}/tomcat $ docker build -t tomcat:1 .ホスト[centos@ip-172-31-0-62 tomcat]$ docker images REPOSITORY TAG IMAGE ID CREATED SIZE nginx-tomcat 1 1e137080691f 14 minutes ago 127MB tomcat 1 5ad4b2b915cf 3 hours ago 523MB ・ ・Dockerネットワーク作成、コンテナ起動

ホスト$ docker network create tomcat-network $ docker run --name tomcat-1 --network tomcat-network -d tomcat:1 $ docker run --name nginx-tomcat-1 --network tomcat-network -p 10080:80 -d nginx-tomcat:1ホスト[centos@ip-172-31-0-62 tomcat]$ docker ps -a CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES ab41de63e013 nginx-tomcat:1 "nginx -g 'daemon of…" 11 seconds ago Up 10 seconds 0.0.0.0:10080->80/tcp nginx-tomcat-1 4949f5632a5a tomcat:1 "/opt/apache-tomcat-…" 20 seconds ago Up 19 seconds tomcat-1ホストから以下サイトを開ければ、nginx経由でtomcatのサイトが開けたことになる

http://localhost:10080/tomcat/

- 投稿日:2020-03-24T23:27:36+09:00

Docker勉強メモ④ コンテナ間通信

はじめに

Docker勉強メモ

- Docker勉強メモ① DockerインストールからHelloWorld

- Docker勉強メモ② Dockerイメージ作ってみる

- Docker勉強メモ③ Dockerfileを作ってDockerイメージ作成からコンテナ起動までやってみる

- Docker勉強メモ④ コンテナ間通信 ←ココ

- Docker勉強メモ⑤ ネットワーク通信やること

コンテナ間通信やってみる。

コンテナ間通信をする方法は2つ

- Dockerネットワークを作成してコンテナ名で接続できるようにする

- 「--link」オプションを使用する「--link」オプションは、レガシーで削除の可能性あり、なので本記事ではスルー

豆知識

Docker のインストールは、自動的に3つのネットワークを作成

ネットワーク確認 :docker network ls

docker0 と表示されるブリッジ( bridge )ネットワーク

docker run --net=<ネットワーク名> と指定しないとdocker0になる

docker0情報は、ホストでifconfigで確認できるコンテナ間通信 : Dockerネットワーク

Dockerネットワーク(bridgeタイプ)を作成

ホスト$ docker network create wordpress-networkネットワークを指定してコンテナを起動する

ホスト$ docker run --name mysql --network wordpress-network -e MYSQL_ROOT_PASSWORD=my-secret-pw -d mysql:5.7 $ docker run --name wordpress --network wordpress-network -e WORDPRESS_DB_PASSWORD=my-secret-pw -p 8080:80 -d wordpress・DBとWebサーバのコンテナを作る

・同じネットワークwordpress-networkを指定する

・MySQLのコンテナ名は「mysql」とする

↑WordPressのDockerイメージは、MySQLへの接続先の指定のホスト名が「mysql」だから

→これで、WordPressコンテナ(wordpress)からMySQLコンテナ(mysql)に向けて通信可になるポート指定の注意点

ホスト$ docker run --name mysql --network wordpress-network -p 13306:3306 -e MYSQL_ROOT_PASSWORD=my-secret-pw -d mysql:5.7図にするとこんな感じのはず

Dockerイメージを用いてコンテナ間で通信

次は、こんなの作ってみる

※Dockerイメージを用いてコンテナ間で通信するためには、定義ファイルなどに接続先としてコンテナ名を指定しておくことが必要

[centos@ip-172-31-0-62 ~]$ mkdir nginx [centos@ip-172-31-0-62 ~]$ touch nginx/Dockerfile [centos@ip-172-31-0-62 ~]$ mkdir nginx/files [centos@ip-172-31-0-62 ~]$ touch nginx/files/tomcat.conf [centos@ip-172-31-0-62 ~]$ mkdir tomcat [centos@ip-172-31-0-62 ~]$ touch tomcat/Dockerfile [centos@ip-172-31-0-62 ~]$ mkdir tomcat/files [centos@ip-172-31-0-62 ~]$ cd tomcat/files [centos@ip-172-31-0-62 ~]$ wget http://ftp.riken.jp/net/apache/tomcat/tomcat-9/v9.0.31/bin/apache-tomcat-9.0.31.tar.gznginx/DockerfileFROM nginx:latest RUN rm -f /etc/nginx/conf.d/default.conf COPY ./files/tomcat.conf /etc/nginx/conf.d/nginx/files/tomcat.confserver { location /tomcat/ { proxy_pass http://tomcat-1:8080/; } }tomcat/DockerfileFROM centos:latest RUN yum install -y java ADD files/apache-tomcat-9.0.31.tar.gz /opt/ CMD [ "/opt/apache-tomcat-9.0.31/bin/catalina.sh", "run" ]ホスト[centos@ip-172-31-0-62 ~]$ tree . ├── nginx │ ├── Dockerfile │ └── files │ └── tomcat.conf └── tomcat ├── Dockerfile └── files └── apache-tomcat-9.0.31.tar.gzNginxイメージ、Tomcatイメージの作成

ホスト$ cd ${SOME_DIR}/nginx $ docker build -t nginx-tomcat:1 . $ cd ${SOME_DIR}/tomcat $ docker build -t tomcat:1 .ホスト[centos@ip-172-31-0-62 tomcat]$ docker images REPOSITORY TAG IMAGE ID CREATED SIZE nginx-tomcat 1 1e137080691f 14 minutes ago 127MB tomcat 1 5ad4b2b915cf 3 hours ago 523MB ・ ・Dockerネットワーク作成、コンテナ起動

ホスト$ docker network create tomcat-network $ docker run --name tomcat-1 --network tomcat-network -d tomcat:1 $ docker run --name nginx-tomcat-1 --network tomcat-network -p 10080:80 -d nginx-tomcat:1ホスト[centos@ip-172-31-0-62 tomcat]$ docker ps -a CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES ab41de63e013 nginx-tomcat:1 "nginx -g 'daemon of…" 11 seconds ago Up 10 seconds 0.0.0.0:10080->80/tcp nginx-tomcat-1 4949f5632a5a tomcat:1 "/opt/apache-tomcat-…" 20 seconds ago Up 19 seconds tomcat-1ホストから以下サイトを開ければ、nginx経由でtomcatのサイトが開けたことになる

http://localhost:10080/tomcat/

- 投稿日:2020-03-24T23:27:36+09:00

Docker勉強メモ④-コンテナ間通信(1)

はじめに

Docker勉強メモ

- Docker勉強メモ① DockerインストールからHelloWorld

- Docker勉強メモ② Dockerイメージ作ってみる

- Docker勉強メモ③ Dockerfileを作ってDockerイメージ作成からコンテナ起動までやってみる

- Docker勉強メモ④-コンテナ間通信 ←今ここやること

コンテナ間通信やってみる。

コンテナ間通信をする方法は2つ

- Dockerネットワークを作成してコンテナ名で接続できるようにする

- 「--link」オプションを使用する「--link」オプションは、レガシーで削除の可能性あり、なので本記事ではスルー

豆知識

Docker のインストールは、自動的に3つのネットワークを作成

ネットワーク確認 :docker network ls

docker0 と表示されるブリッジ( bridge )ネットワーク

docker run --net=<ネットワーク名> と指定しないとdocker0になる

docker0情報は、ホストでifconfigで確認できるコンテナ間通信 : Dockerネットワーク

Dockerネットワーク(bridgeタイプ)を作成

ホスト$ docker network create wordpress-networkネットワークを指定してコンテナを起動する

ホスト$ docker run --name mysql --network wordpress-network -e MYSQL_ROOT_PASSWORD=my-secret-pw -d mysql:5.7 $ docker run --name wordpress --network wordpress-network -e WORDPRESS_DB_PASSWORD=my-secret-pw -p 8080:80 -d wordpress・DBとWebサーバのコンテナを作る

・同じネットワークwordpress-networkを指定する

・MySQLのコンテナ名は「mysql」とする

↑WordPressのDockerイメージは、MySQLへの接続先の指定のホスト名が「mysql」だから

→これで、WordPressコンテナ(wordpress)からMySQLコンテナ(mysql)に向けて通信可になるポート指定の注意点

ホスト$ docker run --name mysql --network wordpress-network -p 13306:3306 -e MYSQL_ROOT_PASSWORD=my-secret-pw -d mysql:5.7図にするとこんな感じのはず

Dockerイメージを用いてコンテナ間で通信

次は、こんなの作ってみる

※Dockerイメージを用いてコンテナ間で通信するためには、定義ファイルなどに接続先としてコンテナ名を指定しておくことが必要

[centos@ip-172-31-0-62 ~]$ mkdir nginx [centos@ip-172-31-0-62 ~]$ touch nginx/Dockerfile [centos@ip-172-31-0-62 ~]$ mkdir nginx/files [centos@ip-172-31-0-62 ~]$ touch nginx/files/tomcat.conf [centos@ip-172-31-0-62 ~]$ mkdir tomcat [centos@ip-172-31-0-62 ~]$ touch tomcat/Dockerfile [centos@ip-172-31-0-62 ~]$ mkdir tomcat/files [centos@ip-172-31-0-62 ~]$ cd tomcat/files [centos@ip-172-31-0-62 ~]$ wget http://ftp.riken.jp/net/apache/tomcat/tomcat-9/v9.0.31/bin/apache-tomcat-9.0.31.tar.gznginx/DockerfileFROM nginx:latest RUN rm -f /etc/nginx/conf.d/default.conf COPY ./files/tomcat.conf /etc/nginx/conf.d/nginx/files/tomcat.confserver { location /tomcat/ { proxy_pass http://tomcat-1:8080/; } }tomcat/DockerfileFROM centos:latest RUN yum install -y java ADD files/apache-tomcat-9.0.31.tar.gz /opt/ CMD [ "/opt/apache-tomcat-9.0.31/bin/catalina.sh", "run" ]ホスト[centos@ip-172-31-0-62 ~]$ tree . ├── nginx │ ├── Dockerfile │ └── files │ └── tomcat.conf └── tomcat ├── Dockerfile └── files └── apache-tomcat-9.0.31.tar.gzNginxイメージ、Tomcatイメージの作成

ホスト$ cd ${SOME_DIR}/nginx $ docker build -t nginx-tomcat:1 . $ cd ${SOME_DIR}/tomcat $ docker build -t tomcat:1 .ホスト[centos@ip-172-31-0-62 tomcat]$ docker images REPOSITORY TAG IMAGE ID CREATED SIZE nginx-tomcat 1 1e137080691f 14 minutes ago 127MB tomcat 1 5ad4b2b915cf 3 hours ago 523MB ・ ・Dockerネットワーク作成、コンテナ起動

ホスト$ docker network create tomcat-network $ docker run --name tomcat-1 --network tomcat-network -d tomcat:1 $ docker run --name nginx-tomcat-1 --network tomcat-network -p 10080:80 -d nginx-tomcat:1ホスト[centos@ip-172-31-0-62 tomcat]$ docker ps -a CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES ab41de63e013 nginx-tomcat:1 "nginx -g 'daemon of…" 11 seconds ago Up 10 seconds 0.0.0.0:10080->80/tcp nginx-tomcat-1 4949f5632a5a tomcat:1 "/opt/apache-tomcat-…" 20 seconds ago Up 19 seconds tomcat-1ホストから以下サイトを開ければ、nginx経由でtomcatのサイトが開けたことになる

http://localhost:10080/tomcat/

- 投稿日:2020-03-24T22:00:15+09:00

JavaアプリをDockerイメージにするならjibを使うと便利だよ

メリットの多いDocker

コンテナ化技術の一つであるDockerですが、使ってみると数多くのメリットがあります。

実際のメリットについてはネットで検索すると色々出てくるので、この記事ではDockerそのものに関する解説はいたしません。

ただ個人的に強調しておきたいのは、本番環境などへ直接Javaのモジュールやアーカイブなどを配置するようなデプロイしている場合、Dockerイメージをリポジトリにpushするという作業に変えることでたくさんの恩恵を得ることができると思います。Dockerの面倒さ

メリットの多いDockerですが面倒な面もあります。

Dockerfileを書かないといけない。書くためのコマンドやベストプラクティスも学習するとなるとそれなりに面倒です。

ローカル開発環境がWindowsの場合にDocker環境を構築するのも面倒です。jibが解決

もしDockerコンテナ上で動くアプリケーションがJavaで開発されている場合、Googleが提供しているjibを利用することでDockerにまつわるいくつかの面倒さから解放されます。

jibを利用するにあたって必要なのは(gradleを使っている場合)

build.gradleにplugins { id 'com.google.cloud.tools.jib' version '2.1.0' }という設定だけです。

そして仮に

docker-image-to-push/1.0.0というイメージ名でpushしたい場合はjib.to.image = 'docker-image-to-push/1.0.0'と

build.gradleに記述するだけです。

これでgradle jibと実行すればDockerイメージが作成されpushされます。

驚くべきはたったこれだけの設定でいいことと、ローカルにDocker環境が必要でないことです。

もしDocker Hubにアカウントを持っているならjib.to { auth { username 'account' password 'pass' } image 'account/repository:1.0.0' }のように

build.gradleに設定することですぐにjibを試すことができます。

(account, pass, repositoryの部分は環境に合わせて変更してください)上記の例でわかるようにほとんど設定のいらないjibですが、色々設定することも可能です。

まず設定しておいてほしいのは(JavaのソースファイルのエンコーディングがUTF-8の場合)jib.container.environment = [JAVA_TOOL_OPTIONS: '-Dfile.encoding=UTF-8']という設定です。

これがないとソースファイル中に日本語がある場合にエラーになってしまいます。

設定できる内容については configurationから確認できます。以上、jibの紹介でした。

- 投稿日:2020-03-24T20:18:52+09:00

【Laravel】Docker for WindowsでLaradock(+MySQL)に挑戦(※格闘)してみた。【備忘録】

はじめに

Docker for WindowsでLaradockの環境構築をして、Webアプリが作れるところまで記載しております。

DBに関してはMySQLでphpmyadminも利用できるようにしています。

※まだできていませんが、PostgreSQLでの環境構築の格闘記録はこちらにあります。(なんでこんなに難しいの。。。)

https://chobimusic.com/laradock_postgresql/

※僕の備忘録でもあり、構築できるようになるまでにかなり苦労したのでとても長文です。かなりのエラーを潰してきたので、部分部分かいつまんで参考にしていただければと思います。どなたかの参考になれば幸いです。※

参考記事

Windows10でLaradockを使ってLaravel 5.5環境を作る

https://qiita.com/sket88/items/4de708ce394179c61d8a

DockerでMySQL複数バージョンを共存させる

https://qiita.com/tanakaworld/items/427b94ea0435b5dccfa2

LaradockのMySQLに接続できなくてはまった話

https://qiita.com/dnrsm/items/4bd078c17bb0d6888647

laradockの環境設定からMySQL接続まで

https://qiita.com/yknsmullan/items/dea4102cf14b1b66e5af

docker起動でportが確保できないエラーの解決

https://nijoen.net/blog/773/

Dockerでコンテナの停止・削除ができなくなった時の対処法

https://qiita.com/musatarosu/items/31d6293a93e75ca6073e

docker docker-compose コマンド

https://qiita.com/souichirou/items/6e701f6469822a641bdd参考書籍

環境構築

(Dockerのインストールは、書籍を参考にインストール)フォルダ作成。

$ mkdir laravel_app $ cd laravel_app

git cloneコマンドでLaradockのダウンロード後、.envファイルの作成

$ git clone https://github.com/laradock/laradock.git $ cd laradock $ cp env-example .env

.envファイルを編集(※MySQLのバージョンが8.0以上になっているとセキュリティの関係でDockerがうまく動作しないらしい)

MYSQL_VERSION=5.7

APP_CODE_PATH_HOST=../laravel-practice/ //後でインストールするlaravelの名前

コンテナの初期化(実行コマンド※Dockerアプリは起動した状態※)

$ docker-compose up -d nginx mysql workspace phpmyadmin

ここでエラー発生。どうやら3306ポートが使えないらしい。.envファイル上で3306と記載の部分を3307に変更して再度compose upするも同様のエラー。(追記:XAMPPを起動していたのを見落としていました。それが原因。)

XAMPPでも3307のポートを使用しているので、念のためその後ポートは3306に戻す。

ためしに以下のコマンドで起動してみる。

docker-compose up

バカみたいに時間がかかったのでctrl+cで離脱。

docker-compose up -d nginx mysql

上記と同様(3306ポートが使えない。)のエラーが発生。一応下記のコマンドでstatusがupになっていれば起動しているらしい。

$ docker ps

どうやらnginx,php-fpm,workspace,docker:dindは起動してる。記載のないphpmyadminとmysqlが起動していない。

$ docker-compose exec --user=laradock workspace bash laradock@0b80605539aa:/var/www$

ただnginxとworkspaceは起動しているのでとりあえずログインを試みたところログインはできた。

composer create-project laravel/laravel laravel-practice --prefer-dist "5.5.*"

さらにLaravelプロフェクトの作成を試みる。下記ディレクトリに作成されていることを確認。

(ここで最低限、Docker自体は起動していることは確認。MySQLのエラー解決に関しては後述。)exitでコンテナからログアウト。.envファイル(laradock側の共有ディレクトリ)に以下を追記。

DB_HOST=mysql

サービスの終了

docker-compose stop

再起動

docker-compose up -d nginx mysql workspace phpmyadmin

やはり3306ポートエラーになる。XAMPPを終了して3307に変更して再起動。(ここでXAMPPを切り忘れていたことに気付く。)

mysqlが起動した!!どうやらXAMPPと干渉しあってたっぽい。。。(3306はなんなんだ。。。)

ただphpmyadminはエラーで起動できていないので、laravel-practiceの.envファイルを編集して再起動。

DB_CONNECTION=mysql DB_HOST=127.0.0.1 DB_PORT=3306 DB_DATABASE=homestead DB_USERNAME=homestead DB_PASSWORD=secret

⇓以下のように編集

DB_CONNECTION=mysql DB_HOST=mysql DB_PORT=3307 DB_DATABASE=default DB_USERNAME=default DB_PASSWORD=secret

再起動してみてもphpmyadminのエラーは変わらず。ダメもとでコンテナにログインしてmigrateしたところ下記のようなエラー。

そもそもartisanコマンドすら利かないことが判明。。。

$ docker-compose exec --user=laradock workspace bash laradock@0b80605539aa:/var/www$ php artisan migrate Could not open input file: artisan

localhostへアクセスしてもnot found。hostsファイルやらDockerの初期設定にも間違いがあるかもしれない。戦いは続く…

再挑戦編

phpmyadminとの格闘

PCを再起動してからDockerを再起動してみる。phpmyadminは変わらず起動しない。

※0.0.0.0:8080のバインドに失敗しました:ポートは既に割り当てられています

netstat -ano | find ":8080" find: ‘:8080’: No such file or directory

このコマンドでポートで何が使用されているかわかるらしいが何も反応せず。。。

docker ps -a

調べると以前のプロセスもこのコマンドでチェックできるとのことで実行。7 weeks agoとめちゃくちゃ怪しいログを発見。

docker rm docker ps -a -q

こちらで停止できるとのことだが

Error response from daemon: You cannot remove a running container

(デーモン(メモリ上の常駐ソフトウェア)からのエラー応答:実行中のコンテナを削除できません)終了できそうなコマンドを一通り入力。

docker-compose kill docker stop $(docker ps -a -q) docker rm $(docker ps -a -q)

再起動するも変わらないので、まだ削除されていないコンテナがあるっぽい。。。

docker ps //起動中のコンテナを表示。 docker rm --force <コンテナID> //指定のコンテナを強制終了

見つけたコンテナを強制終了して再起動するもport被りの状況は変わらず。。。

docker-compose up -d

ためしに上記コマンド。(鬼時間かかる。。。おそらく3時間くらい待った。)長すぎるので割愛。最後の文が赤字の時点でアウト。。。以下の通り何も表示されない。待った意味。。。一旦ステイ。。。

$ docker ps CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

MySQLとの格闘

たまたまこんなものを見つける。(いつ入れたのか全く覚えていない。これが干渉している??)

見つけた。どうやらLaravelを学習する際に入れた模様。

一応MAMPインストールした過去があったのでこちらの共存も気になったが、起動してなければ特にコンフリクト(衝突)することはないそうなので追求せず。

とりあえずこいつを停止してみた。

おそらくこいつのせいでXAMPPのポートも3306で起動できず、3307に変更せざるを得なかったんだなと気づく。

とりあえず3306にDocker内のファイルを変更してみる。mysqlは3306でも起動するようになった!!

残る問題はphpmyadminとartisanコマンドの実行だ。。。

artisanコマンドとの格闘

laradock@48ebb9bcd534:/var/www$ php artisan serve Could not open input file: artisan $ cd laravel-practice $ php artisan serve Laravel development server started: <http://127.0.0.1:8000>

ディレクトリが違うだけだった。。。が、http://127.0.0.1:8000にアクセスしてもエラー。

コンテナからexitしてもしやと思いコンテナに入らずにアクセス。

表示された。(これであってるのか。。。??) 追記:コンテナで環境構築してるのでartisan serveは不要なのを後に知る。

ためしにdockerを終了してからアクセスしたところ表示されないので合ってるっぽい。とりあえず構築成功??

マイグレートも失敗。これはテーブル作成などもしてないからなんとなく理解できる。

php artisan migrate

phpmyadminとの格闘②

docker-compose.ymlのphpmyadminのポート番号を8081に変更。

//ポートのみ変更した場合 phpmyadmin: build: ./phpmyadmin environment: - PMA_ARBITRARY=1 - MYSQL_USER=root - MYSQL_PASSWORD=password - MYSQL_ROOT_PASSWORD=password ports: - 8081:80 //サーバ名を調べるのに試行錯誤したパターン。※ログインエラー。 mysql: build: context: ./mysql args: - MYSQL_VERSION=${MYSQL_VERSION} environment: - MYSQL_DATABASE=DB - MYSQL_HOST=DB - MYSQL_USER=root - MYSQL_PASSWORD=password - MYSQL_ROOT_PASSWORD=password - TZ=${WORKSPACE_TIMEZONE} phpmyadmin: build: ./phpmyadmin environment: - PMA_ARBITRARY=1 - PMA_HOST=mysql - PMA_USER=root - PMA_PASSWORD=password ports: - 8081:80

全てきれいにdoneになった。泣 (そして一体8080ポートは何に使用しているんだろうか。。。)http://localhost:8081でphpmyadminへアクセス。

サーバ名。。。わからずログインできず。。。

(その後かなり格闘した末。。。)laravel-practiceの.envに従い入力したところログインに成功。

サーバ:mysql

ユーザー:default

パスワード:secret以下参照

DB_CONNECTION=mysql DB_HOST=mysql DB_PORT=3307 DB_DATABASE=default DB_USERNAME=default DB_PASSWORD=secret

喜びも束の間。データベースを作成する特権がありません。と表示。.envファイルにこんな記載があるのを思い出す。ユーザーrootでパスワードrootを入力したところログイン。編集もできた◎

MYSQL_ROOT_PASSWORD=root

mysql -u root -p root //こちらからもアクセス可能

create database default; //DB作成

ところがコンテナ内でmigrateはできず。。。次はちゃんと教材見ながらトライしてみよう。。。挑戦はまだまだ続く。。。

日を改め再チャレンジ

PostgreSQLでサイトの表示まではできたので、再度チャレンジ。(以下参考。)https://chobimusic.com/laradock_postgresql/

compose upの前に.envファイルを編集。

APP_CODE_PATH_HOST=../laravel #laravelのプロジェクトファイル名に書き換え DATA_PATH_HOST=../data #複数データを参照してしまう可能性があるため COMPOSE_PROJECT_NAME=docker_mysql #dockerのコンテナ名を変更 MYSQL_VERSION=5.7 #latestから変更 DB_HOST=mysql #追記

さらにdocker-compose.ymlのphpmyadminのポート番号を8081に変更。(MySQL Notifierも毎回起動するので停止させておく。)コマンド実行。もはや1つもdoneされない状況に。。。泣 前は表示されなかったのに。

$ docker-compose up -d nginx mysql workspace phpmyadmin

【ERROR: Service 'php-fpm' failed to build: The command '/bin/sh -c if [ ${INSTALL_IMAGEMAGICK} = true ]; then apt-get install -y libmagickwand-dev imagemagick && pecl install imagick && docker-php-ext-enable imagick ;fi' returned a non-zero code: 100】でサービス 'php-fpm'の構築に失敗しているとのこと。

以下の記事を参考に、php-fpmディレクトリのDockerfileにて以下をImageMagickの欄に追記。再度試したところdoneと表示◎

http://domwp.hatenablog.com/entry/2019/01/30/151146

apt-get update && \laravelのバージョンを教本だと5.5のところあえて6.8で今回はチャレンジ。成功。

$ docker-compose exec workspace composer create-project --prefer-dist laravel/laravel . "6.8.*" Application key set successfully.

Laravelアプリ トップ画面 http://localhost/

phpmyadmin トップ画面 http://localhost:8081/以下でphpmyadminにログイン。DBにdocker_mysqlがあること確認。

サーバ名:mysql

ユーザー名:root

パスワード:rootLaravel側の.envファイルを編集。

DB_CONNECTION=mysql DB_HOST=mysql DB_PORT=3306 DB_DATABASE=docker_mysql DB_USERNAME=root DB_PASSWORD=root

コントローラー作成

コントローラー作成はOK

$ docker-compose exec workspace php artisan make:controller ArticleController Controller created successfully.

DB作成

マイグレーションファイルの作成。

$ docker-compose exec workspace php artisan make:migration create_articles_table --create=articles Created Migration: 2020_03_24_092458_create_articles_table

マイグレート。初めてマイグレートに成功◎laravel側の.envファイルをrootユーザーで記入したからっぽい。

$ docker-compose exec workspace php artisan migrate Migration table created successfully. Migrating: 2014_10_12_000000_create_users_table Migrated: 2014_10_12_000000_create_users_table (0.13 seconds) Migrating: 2014_10_12_100000_create_password_resets_table Migrated: 2014_10_12_100000_create_password_resets_table (0.13 seconds) Migrating: 2019_08_19_000000_create_failed_jobs_table Migrated: 2019_08_19_000000_create_failed_jobs_table (0.07 seconds) Migrating: 2020_03_24_092458_create_articles_table Migrated: 2020_03_24_092458_create_articles_table (0.05 seconds)

これでやっとアプリ制作に取り掛かれるようになった。。。泣

- 投稿日:2020-03-24T20:13:56+09:00

【Laravel】Docker for WindowsでMailHogの実装をしてみた。

はじめに

Dockerの環境構築を頑張ろうと思ったきっかけである以下の教材。

https://chobimusic.com/laravel_vue_sns/

Dockerの環境構築ができたので、当時できなかったMailHogの実装に挑戦してみました。

※ちなみに以下が死ぬほど格闘したLaradock(+MySQL)の環境構築の備忘録です。

https://chobimusic.com/laradock_mysql/

MailHogの実装

以下の記事と上記記載の教材を参考に。https://tech.windii.jp/backend/laravel/laravel-mailhog-docker-compose

MailHogのコンテナを起動。http://localhost:8025/にアクセスするとMailHogが表示される。

$ docker-compose up -d mailhog WARNING: Image for service mailhog was built because it did not already exist. To rebuild this image you must use docker-compose build or docker-compose up --build. Creating docker_mysql_mailhog_1 ... done

以降、再起動する場合はコマンドが以下になる。

docker-compose up -d workspace nginx php-fpm postgres mailhog

laravel側の.envを編集。

MAIL_DRIVER=smtp MAIL_HOST=mailhog MAIL_PORT=1025 MAIL_USERNAME=user MAIL_PASSWORD=password MAIL_ENCRYPTION=null

Mailableクラスを作成

$ docker-compose exec workspace php artisan make:mail Test --markdown=emails.test Mail created successfully.

routes/web.phpを編集。

use Illuminate\Support\Facades\Mail; use App\Mail\Test; Route::get('/', function () { return view('welcome'); }); Route::get('/test', function () { Mail::to('test@example.com')->send(new Test); return 'メール送信しました!'; });

http://localhost/test

にアクセス。http://localhost:8025

にアクセス。無事確認できました◎XAMPP環境下では、MailHogの実装ができなかったので嬉しい!!

- 投稿日:2020-03-24T18:08:24+09:00

【環境構築】dockerでvue.js+Typescript+vuetify+express+Sequelizeの環境構築

dockerファイル作成

ディレクトリを作成

consolemkdir nodeconsolecd node vim Dockerfilenode.jsを準備

dockerファイルを作成し、そこから各種プログラムを実行できるようにする。

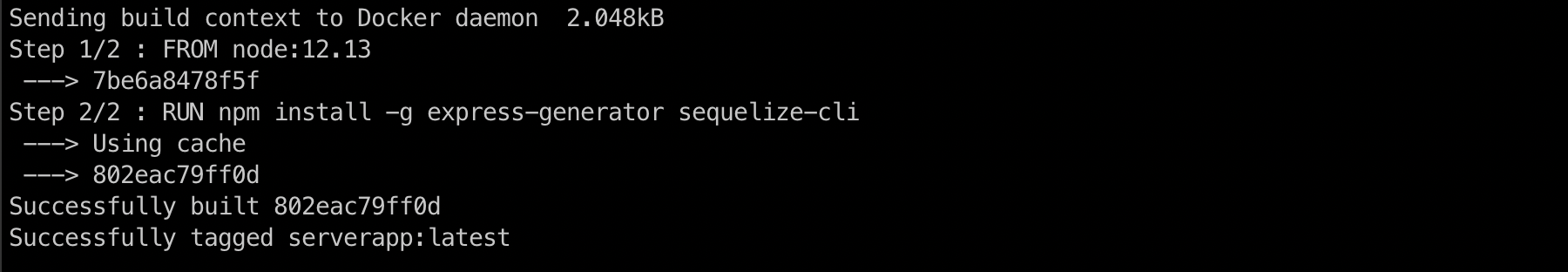

ここではexpress,suquelize-cliの実行環境の構築ができるよう記載。DockerfileFROM node:12.13 RUN npm install -g express-generator sequelize-cliFROM nodeでノードのベースイメージ

RUNコマンドでnpm installを実行しexpressとsepulize-cliをインストールするコマンドdocker イメージを作成

これによりDockerfileが実行される。

consoledocker build node/. -t serverapp:latest-tオプションを付けていることで、名前(serverapp)とタグ名(latest)を指定している。

docker run -itd --rm --name serverapp -v $PWD/node:/node serverapp:latestオプションの説明

-itd コンテナを継続的に動かすために必要

--rm コンテナ終了時自動的に削除。

--name serverappというコンテナ名前で作成

-v ホスト側のディレクトリ:コンテナ側のマウントポイント

今回の場合は$PWDで現在いるディレクトリの/nodeがホスト側、/node serverapp:latestがマウントポイントとなる。express,sequelizeをインストールする

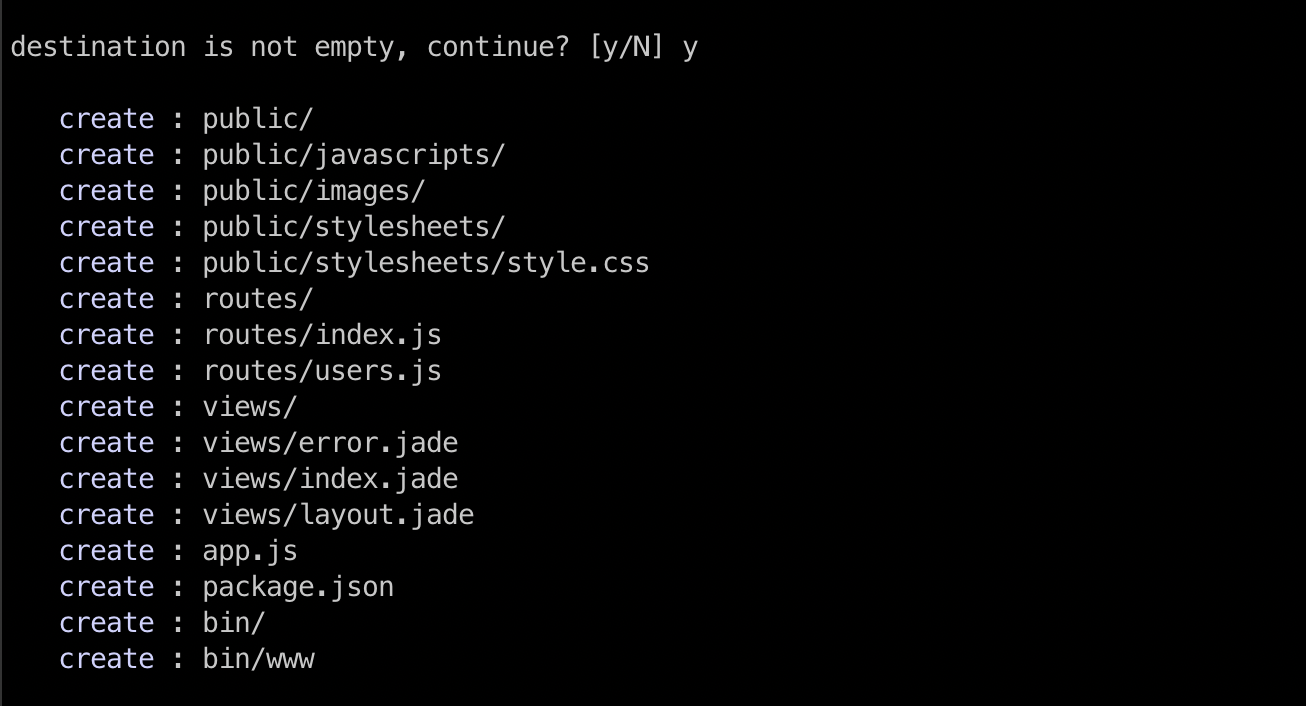

ドッカーコンテナにログインしexpressをインストールしていきます。

コンテナにロングインする。consoledocker exec -it serverapp /bin/bashdocker exec -it <コンテナ名>/bin/bash コンテナにログイン

-it コンテナを継続的に動かすために必要rootcd /node express .destination is not empty, continue?(空ファイルじゃないけど大丈夫?)と聞かれますが、中にはDockerfaileがあるだけなので[y]で続行する。

sequelizeなどの準備

ここで色々必要になるものの準備を行います。

rootnpm install --save sequelize sqlite3 cors nodemon npm installそれぞれ簡単解説

ここでは詳しい説明はしませんが、別記事をそれぞれ作成しようと思います。

名称 説明 sequelize データベースを管理するツール sqlite3 簡易版データベース cors セキュリティ上のルール nodemon 自動でサーバーを再起動してくれるツール これでローカルフォルダのnode/にファイルが作成できたはず。

sequelizeをセットアップ

rootsequelize initターミナルに戻る

rootexitnode/config/config.jsonの記載を変更する。

変更点

database mysql → sqliteへの変更

storage "./data/development.sqlite3"の記載をそれぞれに追加config.config.json{ "development": { "username": "root", "password": null, "database": "database_development", "host": "127.0.0.1", "dialect": "sqlite", "storage": "./data/development.sqlite3", "operatorsAliases": false }, "test": { "username": "root", "password": null, "database": "database_test", "host": "127.0.0.1", "dialect": "sqlite", "storage": "./data/test.sqlite3", "operatorsAliases": false }, "production": { "username": "root", "password": null, "database": "database_production", "host": "127.0.0.1", "dialect": "sqlite", "storage": "./data/production.sqlite3", "operatorsAliases": false } }nodeファイルの中にconfig.jsonで指定したdataファイルを作成。

consolemkdir node/dataもう一度dockerコンテナにログイン

consoledocker exec -it serverapp /bin/bashUnable to resolve sequelize package in

sequleize model:createコマンドを使いデータベースに雛形を作成

sequelize model:createコマンドとは?rootsequelize model:create --name goal --underscored --attributes goalname:stringUnable to resolve sequelize package inのエラーが出る場合はこちら

マイグレートする

そもそもマイグレートとは、アプリケーションで使うデータベースの定義を自動的に作成・管理する機能です。

rootsequelize db:migrateマイグレートが完了したら一度dockerを停止する。

terminaldocker stop serverappvueの準備

ディレクトリを作成

consolemkdir vueconsolevim vue/Dockerfile作成したfrontapp内のDockerfileに以下の記述をする。

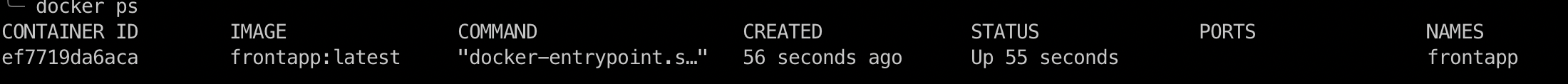

ここではvue/cliの実行環境の構築ができるよう記載。DockerfileFROM node:12.13 RUN npm install -g @vue/cliDockerfileを元にコンテナイメージを作成。起動し、ローカルのフォルダをマウント。

consoledocker build vue/. -t frontapp:latestconsoledocker run -itd --rm --name frontapp -v $PWD/vue:/vue frontapp:latestdocker run コマンドが正常に動いているか確認。

consoledocker psconsoledocker exec -it frontapp /bin/bashコンテナにログイン後以下を実行する。

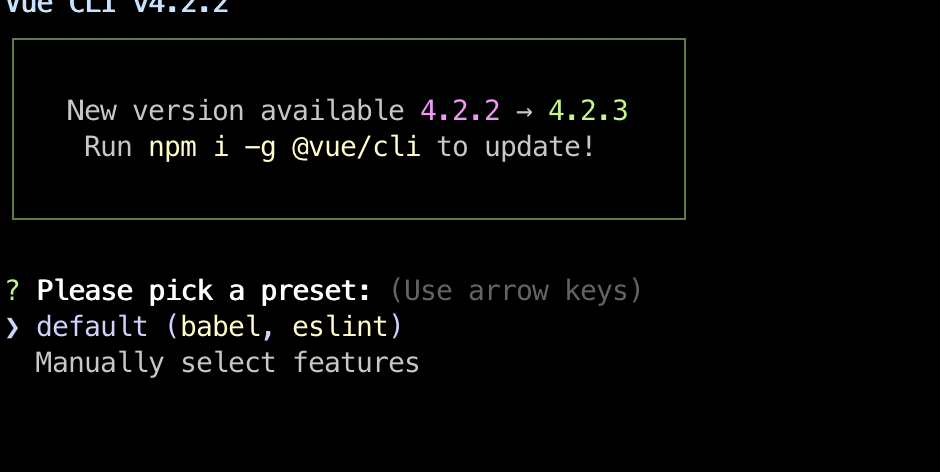

rootcd /vue vue create frontapp以下のように標準のyarnか高速のnpmどちらかで実行

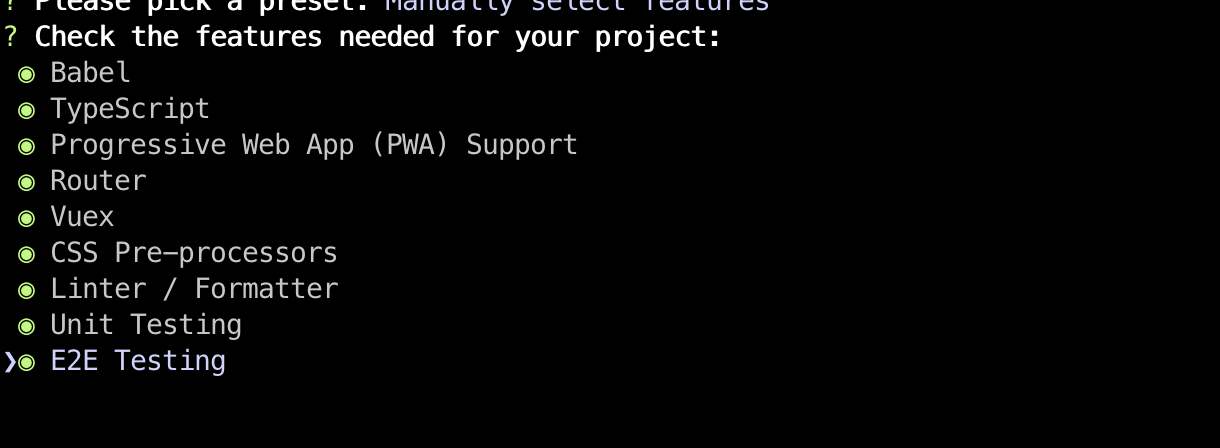

npmで実行したいため[y]を選択する。rootYour connection to the default yarn registry seems to be slow. Use https://registry.npm.taobao.org for faster installation?以下のメッセージに従いvueをインストールしていく。

今回はマニュアルでtypescriptなどもインストールしていく。これでvueのインストールは完了です。

vuetifyの環境

frontappに移動し、vuetifyのプラグインを追加する。

インストールはデフォルトで行った。

インストール終了後はexitで一度コンテナからログアウトするconsoleroot@701c15dfea18:/# cd vue/frontapp root@701c15dfea18:/vue/frontapp# vue add vuetify exitdocker-compose.ymlファイルを準備する。

Node.jsとVue.jsそれぞれのコンテナを起動する際、composeファイルがあると起動/終了が楽なので、

docker-compose.ymlを下記のように記入。docker-compose.ymlversion: "3" services: node: build: node/. volumes: - ./node:/node working_dir: /node command: ["npm", "start"] ports: - "3000:3000" vue: build: vue/. volumes: - ./vue:/vue working_dir: /vue/frontapp command: ["npm", "run", "serve"] ports: - "8080:8080"一度バックグランドで実行しそれぞれ表示を確認する。

docker-compose up -d # コンテナ終了は docker-compose downlocalhost:8080でアクセス

localhost:3000でアクセス

参考記事

とてもお世話になりました。ありがとうございました

Vue.js + Express + Sequelize + DockerでCRUD搭載のTodoリストを作ってみる

【環境構築】Docker + Rails6 + Vue.js + Vuetifyの環境構築手順

GitHub PagesにDocker+Vue.js+Vuetifyでページを公開

- 投稿日:2020-03-24T17:13:37+09:00

Memory不足でElasticSearchのDockerコンテナ立ち上げが「exited with code 137」で終了したときの対応方法

DockerでElasticSearchのコンテナを起動しようとしたら起動できなくて、「exited with code 137」というエラー文を吐いてて原因を調べてたら時間取られたのでメモ。

DockerでElasticSearchのコンテナを起動しようとしてエラー

$ docker-compose up <container名> ... <container名> exited with code 137原因

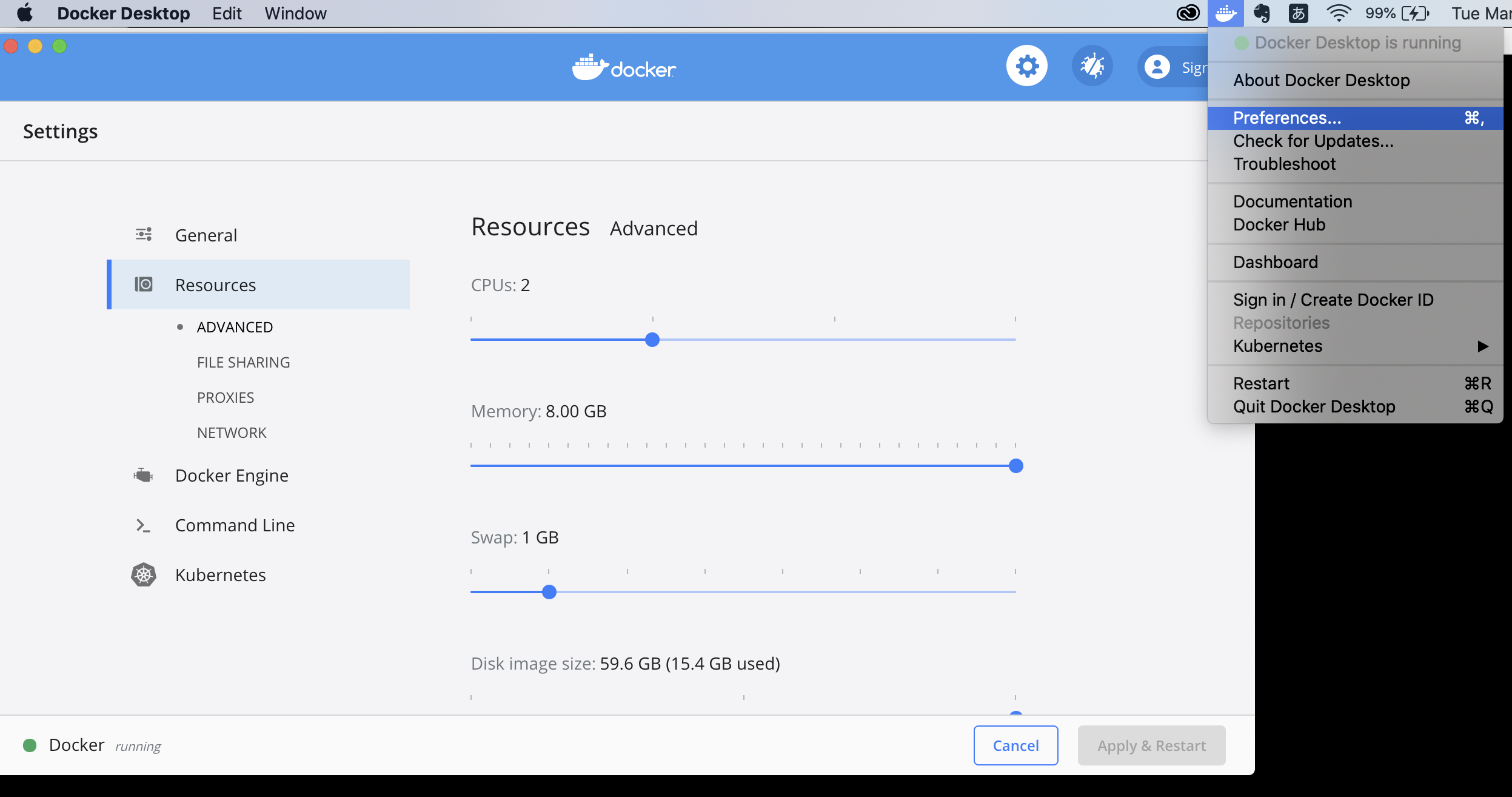

メモリの上限値が少ないからOut Of Memoryエラーになっているよう。

Dockerの初期設定のメモリは2GBになっているけど、ElasticSearchのコンテナはそれ以上にメモリ使うのかな。cf. https://github.com/10up/wp-local-docker/issues/6

対応方法

Dockerのメモリ設定の上限値を上げる。2GBから8GBに上げたら起動できた。

(4GBでも起動できた)

- 投稿日:2020-03-24T16:39:31+09:00

Veritas Flexアプライアンス上のNetBackupインスタンスをアップグレードする手順

1. はじめに

本稿ではVeritas FlexアプライアンスのNetBackupインスタンスをアップグレードする方法についてご紹介します。

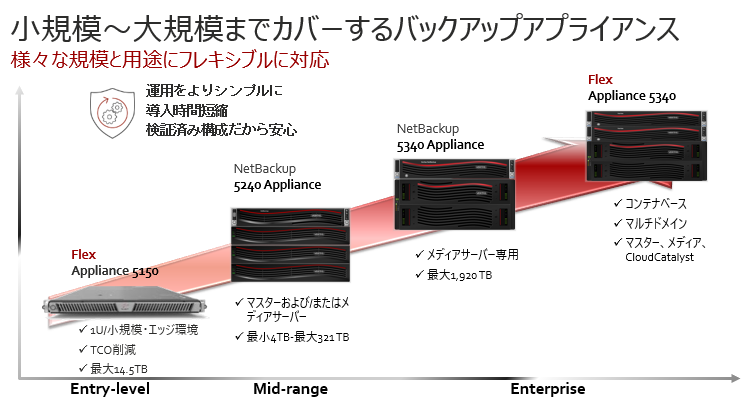

FlexアプライアンスはDockerコンテナを基盤としてNetBackupを構築しているため、非常に可搬性・アジリティに優れており、ブラウザインターフェースから短時間(5分~10分程度で完了)、且つ容易な操作でバージョンアップ作業を完了することができます。2. Veritas Flex アプライアンス とは?

Veritas Flex アプライアンスは Docker コンテナの環境を利用することで複数からなるNetBackupインスタンスを1つのFlexアプライアンスに統合可能です。Flexに統合することでマルチドメイン環境の管理を可能にし、運用効率性の向上、コスト(Capex, Opex)の最適化を実現します。現在、Flex 5150(Edge・SMB環境向け)、Flex5340(統合バックアップ・Enterprise環境向け)がラインナップされています。

3. インスタンスのアップグレード方法

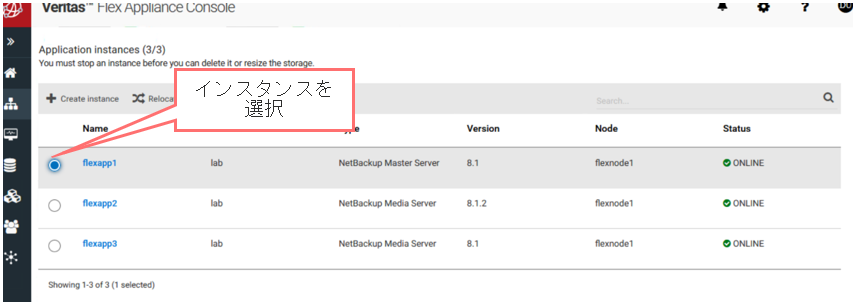

それでは、Flexソフトウェア上にあるNetBackupインスタンスをアップグレードする方法についてご紹介します。

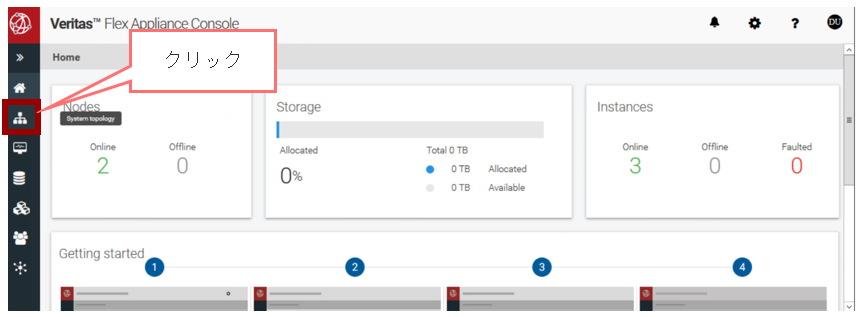

① 左側のFlex アプライアンス コンソールのインターフェイスから、[SystemTopology] のアイコンをクリックします。

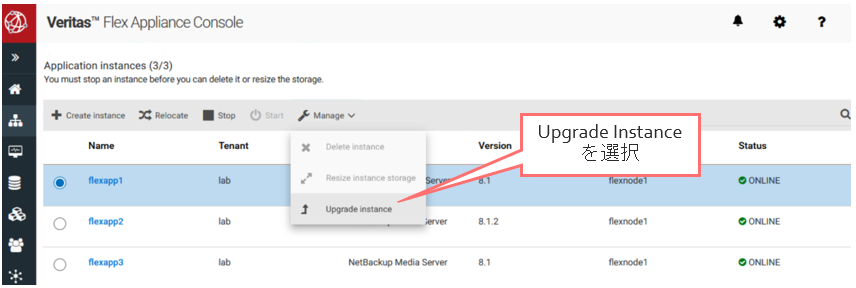

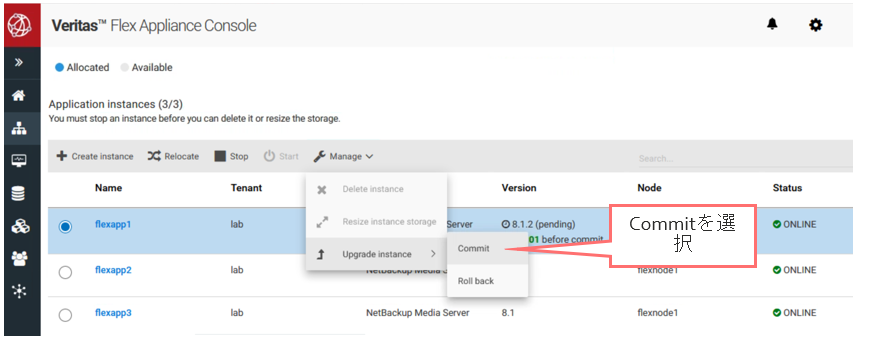

③ [Manage]から[Upgrade Instance]を選択します。

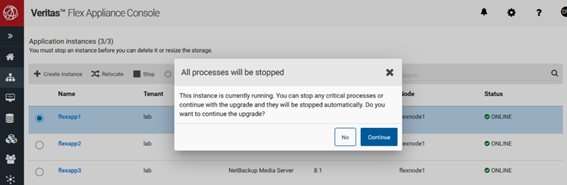

④ メッセージを確認し、[Continue]をクリックします。

⑤ アップグレードしたいバージョンを選択し、[Precheck]を押下します。

互換性のプリチェックが行われます。

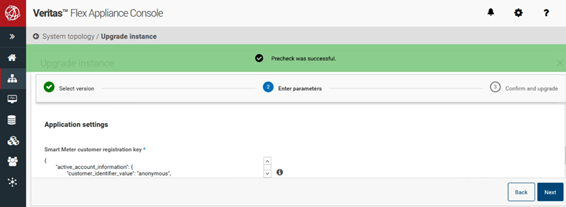

⑥ [Precheck was successful]のメッセージが表示されます。Precheckが完了したら、[Next]ボタンを押下します。

⑦ Smart Meter Customer Registration Keyを入力します。

※Smart Meter Customer Registration KeyとはSmart Meterを利用するため必要なファイルです。Registration KeyはSmart Meterポータル(https://taas.veritas.com/) から入手可能です。

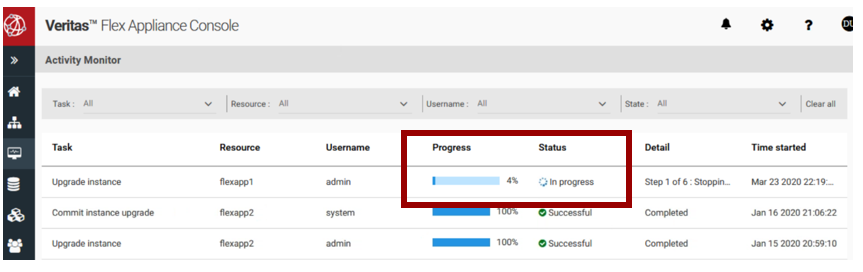

⑨ アップデートが実行され、進捗状況が表示されます。

5分~10分程度で作業は完了します。

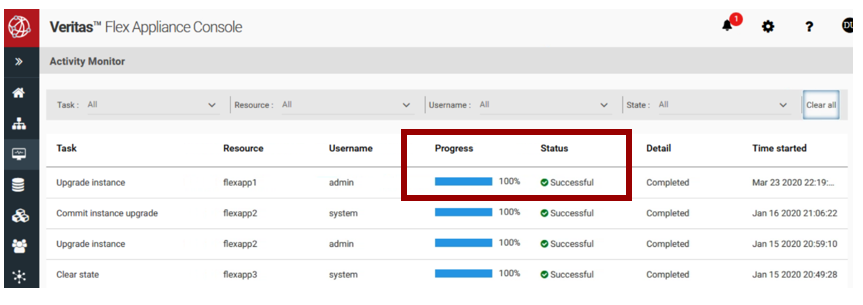

⑩ [Progress]が100%, [Status]がSuccessfulとなりました。

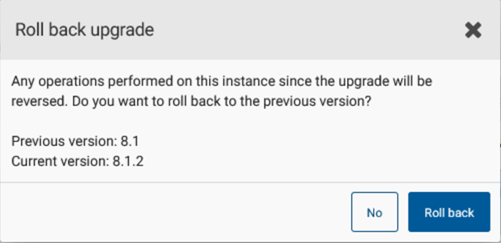

⑪ アップグレードを確定したい場合、[Manage]>[Upgrade Instance]>[Commit]を選択します。 元のバージョンに戻したい場合はRolebackをクリックします。(Commit前で、且つ24時間以内であればロールバックが可能です)

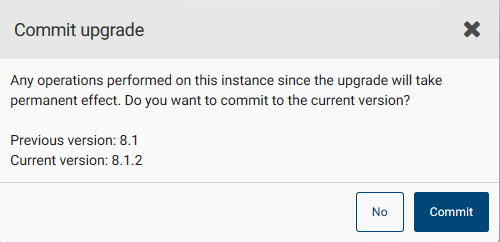

⑫ Commitを選択した場合、メッセージが表示されますのでCommitをクリックしてアップグレード完了となります。

<参考> RoleBackを選択した場合、以下が表示されますのでRoleBackボタンを押下します。

<参考> ロールバックステイタスが表示されます。[Status]にSuccessfulが表示されたらロールバック完了になります。

4. まとめ

いかがだったでしょうか、通常のNetBackupのアップグレードの場合、1~2時間程度かかる作業工程が、GUIの直観的な操作でわずか5分~10分程度で簡単にアップグレードできます。また、アップグレード作業後であっても24時間以内であれば元のバージョンに戻せますのでなにか手違いがあっても安心です。

バックアップの運用負荷、煩雑な管理でお悩みの方は活用を検討されてみてはいかがでしょうか。商談のご相談はこちら

本稿からのお問合せをご記入の際には「お問合せ内容」に#GWCのタグを必ずご記入ください。ご記入いただきました内容はベリタスのプライバシーポリシーに従って管理されます。

- 投稿日:2020-03-24T16:21:30+09:00

GAMESSプログラムで第一原理計算を実行可能なDockerコンテナを作る方法

はじめに

こんにちは,(株)日立製作所 研究開発グループ サービスコンピューティング研究部の露木です。

材料開発にAI・機械学習を適用する際に常に問題となるのがデータ数の少なさです。材料候補の物質を変えながら,大量の実験を繰り返して教師データとなる物性値を測定することは困難であり,少量の実験値から学習を行わなければなりません。しかし幸運なことに,計算化学・計算物理学の理論にもとづいてシミュレーション計算を行えば,第一原理的に物性値を得ることができます。このようにデータセットを補う観点から,機械学習を適用する立場でもシミュレーション計算を実行できる環境を整えることは非常に重要といえます。

本記事でとりあげるGAMESSプログラムは,量子力学にもとづいた繰り返し計算により電子の波動関数を計算し,分子の物性を計算するためのプログラムです。GAMESSはアイオワ州立大学により開発されているプログラムであり,理論化学・計算化学分野における有力なプログラムといえます。GAMESSプログラムは主要な波動関数法 (HF法やMP2法,結合クラスター法,配置間相互作用法など) や 密度汎関数法 (DFT) ベースの電子状態計算,相対論補正や振動状態計算等にも対応しています。同種のプログラムにはGAUSSIANや MOLPRO,TURBOMOLE などがあります。ご興味ある方は,これらプログラムと比較検討してみてください。

本稿ではGAMESSを利用して第一原理的な電子状態計算を行うことを目標に,Dockerコンテナとして実行環境を構築する方法を記します。

手順

コンパイル環境の準備

インターネットには DrSnowbird/hpc-app-gamess や saromleang/docker-gamess などのGAMESS用のDockerfileが既に公開されています。しかし,これらには開発者の環境 (大学) に固有のコードが入っていますので,そのままでは使えません。そこで,今回は汎用的なDockerfileを新たに作りました。

まずは,このリポジトリを clone してDockerfileを入手してください。

git clone <リポジトリのURL> (注. 現時点では未公開。準備完了したら公開します)次に,GAMESSの公式サイトからそのソースコード

gamess-current.tar.gzを入手します。Gordon Group/GAMESS Homepage をWebブラウザで開いてライセンスに合意できるか確認したら,メールアドレスを登録してください。大抵は数時間以内にダウンロード用のURLとパスワードがメールで送付されます。

gamess-current.tar.gzを入手したら解凍します。tar xzf gamess-current.tar.gz次に,GAMESSのコンパイルオプションを対話的に生成していきます。まずはその準備としてbaseコンテナをビルドします。

docker-compose build basebaseコンテナを起動して,シェルにログインします。

docker run --rm -it -v `pwd`/gamess:/opt/gamess base /bin/bash

gamess-current.tar.gzに同梱されているconfigスクリプトを実行してコンパイルオプションを生成します。configスクリプトを実行したら,質問が表示されていきますので環境とお好みに合わせて設定してください。./configご参考までに先程のDockerfileで動作確認済みの設定例を以下に記します。

質問1

まず,

configスクリプトを実行後,最初に表示される質問は単なるイントロダクションなので,読み終わりましたらEnterキーを押してください。This script asks a few questions, depending on your computer system, to set up compiler names, libraries, message passing libraries, and so forth. You can quit at any time by pressing control-C, and then <return>. Please open a second window by logging into your target machine, in case this script asks you to 'type' a command to learn something about your system software situation. All such extra questions will use the word 'type' to indicate it is a command for the other window. After the new window is open, please hit <return> to go on.質問2

2つ目の質問はコンパイルする環境を選ぶものです。今回は 64-bit CPU のLinux として linux64 を選択します。

After the new window is open, please hit <return> to go on. GAMESS can compile on the following 32 bit or 64 bit machines: axp64 - Alpha chip, native compiler, running Tru64 or Linux cray-xt - Cray's massively parallel system, running CNL cray-xc - Cray's XC40, with KNL nodes hpux32 - HP PA-RISC chips (old models only), running HP-UX hpux64 - HP Intel or PA-RISC chips, running HP-UX ibm32 - IBM (old models only), running AIX ibm64 - IBM, Power3 chip or newer, running AIX or Linux ibm64-sp - IBM SP parallel system, running AIX ibm-bg - IBM Blue Gene (Q model), these are 64 bit systems linux32 - Linux (any 32 bit distribution), for x86 (old systems only) linux64 - Linux (any 64 bit distribution), for x86_64 or ia64 chips, using gfortran, ifort, or perhaps PGI compilers. mac32 - Apple Mac, any chip, running OS X 10.4 or older mac64 - Apple Mac, any chip, running OS X 10.5 or newer sgi32 - Silicon Graphics Inc., MIPS chip only, running Irix sgi64 - Silicon Graphics Inc., MIPS chip only, running Irix sun32 - Sun ultraSPARC chips (old models only), running Solaris sun64 - Sun ultraSPARC or Opteron chips, running Solaris win32 - Windows 32-bit (Windows XP, Vista, 7, Compute Cluster, HPC Edition) win64 - Windows 64-bit (Windows XP, Vista, 7, Compute Cluster, HPC Edition) winazure - Windows Azure Cloud Platform running Windows 64-bit singularity - GAMESS Singularity container image type 'uname -a' to partially clarify your computer's flavor. please enter your target machine name:質問3

3つ目の質問はGAMESSのソースコードが置かれている場所を問うものです。正しい答えは

configスクリプトが保存されているカレントディレクトリですので,そのままEnterキーを押してください。Where is the GAMESS software on your system? A typical response might be /u1/mike/gamess, most probably the correct answer is /opt/gamess GAMESS directory? [/opt/gamess]質問4

4つ目の質問はコンパイルしたGAMESSプログラムを配置するディレクトリです。こちらもそのままEnterキーを押してください。

Setting up GAMESS compile and link for GMS_TARGET=linux64 GAMESS software is located at GMS_PATH=/opt/gamess Please provide the name of the build locaation. This may be the same location as the GAMESS directory. GAMESS build directory? [/opt/gamess]質問5

5個目の質問はGAMESSのバージョンを問うものです。このバージョンはコンパイルする人が区別するために決めるものなので,任意の値で構いません。ここではデフォルトの

00のままEnterキーを押します。Please provide a version number for the GAMESS executable. This will be used as the middle part of the binary's name, for example: gamess.00.x Version? [00]質問6

6つ目の質問はコンパイラを選択するものです。今回は

gfortranと入力して Enterキーを押します。今回のDockerfileでは利用不可能ですが,もしもお手元に intelのfortranコンパイラ (ifort) のライセンスがあり,利用可能であればそちらのほうが高速になります。Linux offers many choices for FORTRAN compilers, including the GNU compiler suite's free compiler 'gfortran', usually included in any Linux distribution. If gfortran is not installed, it can be installed from your distribution media. To check on installed GNU compilers, for RedHat/SUSE style Linux, type 'rpm -aq | grep gcc' for both languages, and for Debian/Ubuntu style Linux, it takes two commands type 'dpkg -l | grep gcc' type 'dpkg -l | grep gfortran' There are also other compilers (some commercial), namely Intel's 'ifort', Portland Group's 'pgfortran', Pathscale's 'pathf90', AMD's 'AOCC', and ARM's armflang. The last four are not common, and aren't as well tested. type 'which gfortran' to look for GNU's gfortran (a good choice), type 'which ifort' to look for Intel's compiler (a good choice), type 'which pgfortran' to look for Portland Group's compiler, type 'which pathf90' to look for Pathscale's compiler. type 'which aocc' to look for AMD's compiler. type 'which armflang' to look for ARM compiler. Please enter your choice of FORTRAN:質問7

次の質問は gfortran のバージョンを問うものです。 gfortran -v コマンドを実行すればバージョンを確認できますが,今回のDockerfileであれば 7.4 を入力してEnterキーを押してください。

Linux offers many choices for FORTRAN compilers, including the GNU compiler suite's free compiler 'gfortran', usually included in any Linux distribution. If gfortran is not installed, it can be installed from your distribution media. To check on installed GNU compilers, for RedHat/SUSE style Linux, type 'rpm -aq | grep gcc' for both languages, and for Debian/Ubuntu style Linux, it takes two commands type 'dpkg -l | grep gcc' type 'dpkg -l | grep gfortran' There are also other compilers (some commercial), namely Intel's 'ifort', Portland Group's 'pgfortran', Pathscale's 'pathf90', AMD's 'AOCC', and ARM's armflang. The last four are not common, and aren't as well tested. type 'which gfortran' to look for GNU's gfortran (a good choice), type 'which ifort' to look for Intel's compiler (a good choice), type 'which pgfortran' to look for Portland Group's compiler, type 'which pathf90' to look for Pathscale's compiler. type 'which aocc' to look for AMD's compiler. type 'which armflang' to look for ARM compiler. Please enter your choice of FORTRAN: gfortran gfortran is very robust, so this is a wise choice. Please type 'gfortran -dumpversion' or else 'gfortran -v' to detect the version number of your gfortran. This reply should be a string with at least two decimal points, such as 4.9.4 or 6.3.0. The reply may be labeled as a 'gcc' version, but it is really your gfortran version. Please enter only the first decimal place, such as 4.9:質問8

このコメントはgfortarnのバージョンが適合していることを教えてくれているだけですので,そのままEnterキーを押して次に進んでください。

Good, the newest gfortrans can compile REAL*16 data type. Please report any numerical issues you encounter. hit <return> to continue to the math library setup.質問9

数値計算を高速化するためのライブラリとして,何をつかうか質問されています。今回は

atlasをつかうので,atlasと入力してから Enterキーを押してください。Linux distributions do not include a standard math library. There are several reasonable add-on library choices, MKL from Intel for 32 or 64 bit Linux (very fast) ACML from AMD for 32 or 64 bit Linux (free) LibFLAME from AMD for 64 bit Linux (free) ATLAS from www.rpmfind.net for 32 or 64 bit Linux (free) PGI BLAS from Portland Group for 32 or 64 bit Linux ArmPL from ARM for 64 bit Linux and one very unreasonable option, namely 'none', which will use some slow FORTRAN routines supplied with GAMESS. Choosing 'none' will run MP2 jobs 2x slower, or CCSD(T) jobs 5x slower. Some typical places (but not the only ones) to find math libraries are Type 'ls /opt/intel/mkl' to look for MKL Type 'ls /opt/intel/Compiler/mkl' to look for MKL Type 'ls /opt/intel/composerxe/mkl' to look for MKL Type 'echo $MKLROOT' to look for MKL Type 'ls -d /opt/acml*' to look for ACML Type 'ls -d /usr/local/acml*' to look for ACML Type 'ls /usr/lib64/atlas' to look for Atlas Type 'ls /opt/pgi/linux86-64/*/lib/* to look for libblas.a from PGI Type 'ls /opt/pgi/osx86-64/*/lib/* to look for libblas.a from PGI Type 'echo $ARMPL_DIR' to look for ArmPL Enter your choice of 'mkl' or 'atlas' or 'acml' or 'libflame' or 'openblas' or 'pgiblas' or 'armpl' or 'none':質問10

次の質問は

atlasをインストールしたディレクトリを問うものです。/usr/lib/x86_64-linux-gnu/atlasを入力して Enterキーを押してください。Where is your Atlas math library installed? A likely place is /usr/lib64/atlas **BOLT: /shared/math/atlas/3.10.3-gnu-4.8.5-skylake **BOLT: /shared/math/atlas/3.10.3-gnu-4.8.5-amd-epyc **BOLT: /shared/math/atlas/3.10.3-gnu-4.8.5-skylake-lapack **BOLT: /shared/math/atlas/3.10.3-gnu-4.8.5-amd-epyc-lapack Please enter the Atlas subdirectory on your system:質問11

この質問は注意事項を述べているだけですので,そのままEnterを押します。

The linking step in GAMESS assumes that a softlink exists within the system's /usr/lib/x86_64-linux-gnu/atlas from libatlas.so to a specific file like libatlas.so.3.0 from libf77blas.so to a specific file like libf77blas.so.3.0 config can carry on for the moment, but the 'root' user should chdir /usr/lib/x86_64-linux-gnu/atlas ln -s libf77blas.so.3.0 libf77blas.so ln -s libatlas.so.3.0 libatlas.so prior to the linking of GAMESS to a binary executable. Math library 'atlas' will be taken from /usr/lib/x86_64-linux-gnu/atlas please hit <return> to compile the GAMESS source code activator質問12

このメッセージは自動設定用プログラムのコンパイルに成功したことを示すものです。そのままEnterを押してください。

gfortran -o /opt/gamess/tools/actvte.x actvte.f unset echo Source code activator was successfully compiled. please hit <return> to set up your network for Linux clusters.質問13

並列計算の方法に関する質問です。今回はDockerであり,ノード間並列計算 (mpi) の利用は困難ですので単一のノードに閉じた並列計算のみを有効化します。

socketsを入力してEnterキーを押してください。If you have a slow network, like Gigabit Ethernet (GE), or if you have so few nodes you won't run extensively in parallel, or if you have no MPI library installed, or if you want a fail-safe compile/link and easy execution, choose 'sockets' to use good old reliable standard TCP/IP networking. If you have an expensive but fast network like Infiniband (IB), and if you have an MPI library correctly installed, choose 'mpi'. If you wish to use a combination of TCP/IP networking for small messages and MPI for large messages in a 'mixed' fashion, choose 'mixed'. communication library ('serial','sockets' or 'mpi' or 'mixed')?質問14

クラスター結合法に関するベータ版のコードをコンパイルするかという質問です。時間がかかる上に収束が難しい計算手法ですし,コンパイルも異様に遅くなりますから特別な事情が無い限りは

noにしておきます。Users have the option of compiling the beta version of the active-space CCSDt and CC(t;3) codes developed at Michigan State University (CCTYP = CCSD3A and CCT3, respectively). These builds take a considerable amount of time and memory for compilation due to the amount of machine generated source code. We recommend that users interested in installing these codes compile GAMESS in parallel using the Makefile generated during the initial configuration ('make -j [number of cores]'). This option can be manually changed later by modifying install.info Optional: Build Michigan State University CCT3 & CCSD3A methods? (yes/no):質問15

最後の質問はGPUによる高速化ライブラリの利用に関する質問です。今回はGPUを利用する予定は無いので

noを選びます。64 bit Linux and IBM builds can attach a special LIBCCHEM code for fast MP2 and CCSD(T) runs. The LIBCCHEM code can utilize nVIDIA GPUs, through the CUDA libraries, if GPUs are available. Usage of LIBCCHEM requires installation of HDF5 I/O software as well. GAMESS+LIBCCHEM binaries are unable to run most of GAMESS computations, and are a bit harder to create due to the additional CUDA/HDF5 software. Therefore, the first time you run 'config', the best answer is 'no'! If you decide to try LIBCCHEM later, just run this 'config' again. Do you want to try LIBCCHEM? (yes/no):GAMESSプログラムのコンパイル

すべての質問に答えたら,GAMESSプログラムを含むDockerイメージをビルドします。下記コマンドを実行するとGAMESSプログラムをソースコードからコンパイルするため,しばらく時間がかかります。

docker-compose build docker-gamessおわりに

以上でコンパイルは終わりです。環境準備はできましたので,いよいよGAMESSを使えるようになりましたが記事が長くなってしまいましたので,使い方は次回に解説します。

参考URL

- 投稿日:2020-03-24T15:46:00+09:00

MacOS の VirtualBox Ubntu上にDocker環境を構築

MacOS の VirtualBox Ubntu上にDocker環境を構築

下記の手順で作業を行います。

1. MacOS上のVirtualBoxにゲストOSとしてUbntuをインストール

2. ゲストOSのUbntu上にDocker環境を構築MacOS の VirtualBox にUbntuをゲストOSとしてインストール

VirtualBoxを入手する

VirtualBox binaries

https://www.virtualbox.org/wiki/DownloadsMacの場合は、「OS X Hosts」をクリックします。

Ubuntuを入手してインストール

Ubuntu Desktop 18.04.4 LTS

https://jp.ubuntu.com/downloadVirtualboxのホストオンリーネットワークを作成

ホストOSで通信するために、Virtualboxのホストオンリーネットワークを作成します。

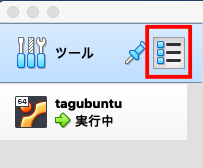

ホストOSの設定ではないのでクリックする場所に注意。

クリックするだけで設定等は自動で行われます。

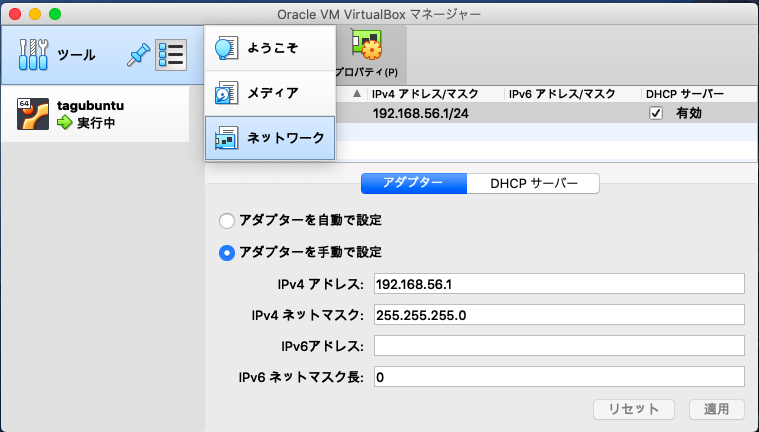

自動入力される設定の例(環境によって設定内容は変わります、デフォルトのままでOK、修正不要):

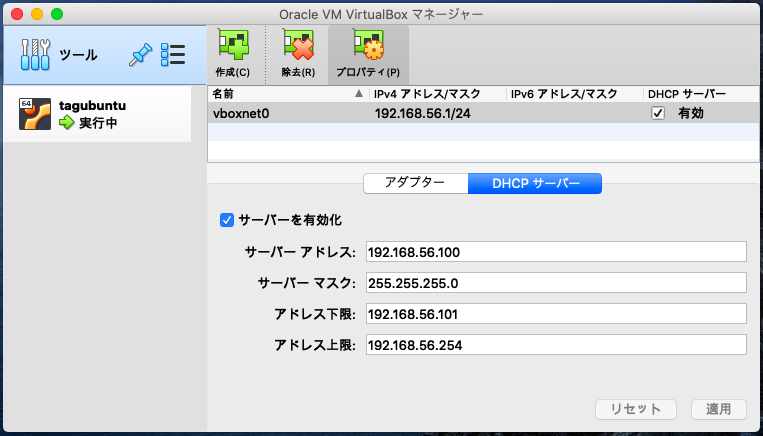

DHCPの設定も勝手に入ると思います。

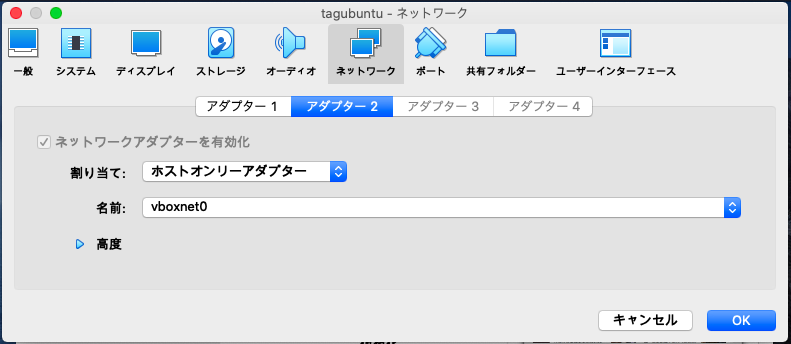

VirtualboxのゲストOS用ネットワークを作成

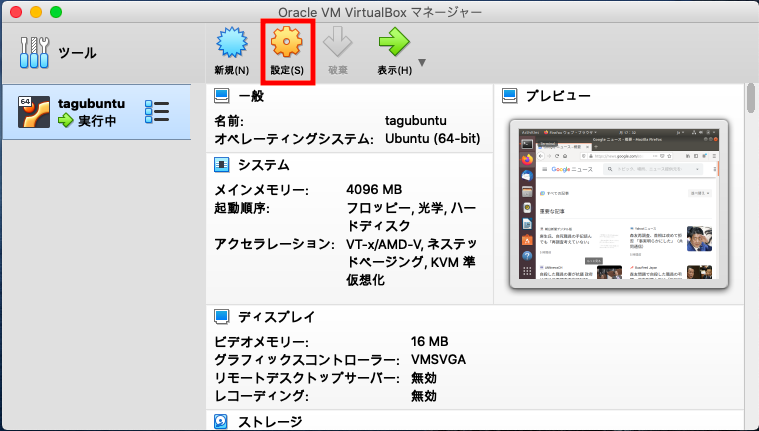

今度はゲストOS用のネットワーク設定です。クリックする場所に注意。

ネットワーク の アダプター2 に 割り当て ホストオンリーアダプター を選択します。

名前 で、先ほど作成したホストオンリーアダプターを選択できるはずです。

ゲストOS(Ubuntu)でインターネット通信が可能かを確認

Firefox(Webブラウザ)等で、インターネットに接続可能になったことを確認してください。

ゲストOS(Ubuntu)のアップデート

アップデートを行います。

sudo apt update sudo apt upgradeNet-toolsのインストール

IPの確認にifconfigを利用したいので、インストールしておきます。

sudo apt-get install net-toolssshのインストール

ホストOSからゲストOSへの作業時にsshを利用したいので、インストールしておきます。

セキュリティ対策等は各自でお願いします。sudo apt-get install ssh systemctl start sshd私の環境でのssh例(当然、IPやI/F等は各自の環境で変わってきます)

ゲストOSにログインし、sshが起動していることを確認します。

tagucchan@tagvirtualbox01:~$ ps -ef | grep ssh tagucch+ 1752 1675 0 10:50 ? 00:00:00 /usr/bin/ssh-agent /usr/bin/im-launch env GNOME_SHELL_SESSION_MODE=ubuntu gnome-session --session=ubuntu root 4945 1 0 10:55 ? 00:00:00 /usr/sbin/sshd -D root 6000 4945 0 10:57 ? 00:00:00 sshd: tagucchan [priv] tagucch+ 6090 6000 0 10:58 ? 00:00:00 sshd: tagucchan@pts/1 tagucch+ 6117 6091 0 11:00 pts/1 00:00:00 grep --color=auto sshsshが起動中ですので、ゲストOS(Ubuntu)のIPを調べます。

tagucchan@tagvirtualbox01:~$ ifconfig enp0s3: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500 inet 10.0.2.15 netmask 255.255.255.0 broadcast 10.0.2.255 inet6 fe80::3306:660:8dc9:8a3e prefixlen 64 scopeid 0x20<link> ether 08:00:27:e9:85:d9 txqueuelen 1000 (Ethernet) RX packets 19747 bytes 19014822 (19.0 MB) RX errors 0 dropped 0 overruns 0 frame 0 TX packets 7266 bytes 488706 (488.7 KB) TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0 enp0s8: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500 inet 192.168.56.101 netmask 255.255.255.0 broadcast 192.168.56.255 inet6 fe80::ff08:5ca7:204b:8b9c prefixlen 64 scopeid 0x20<link> ether 08:00:27:88:8e:37 txqueuelen 1000 (Ethernet) RX packets 83 bytes 12617 (12.6 KB) RX errors 0 dropped 0 overruns 0 frame 0 TX packets 119 bytes 16465 (16.4 KB) TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0 lo: flags=73<UP,LOOPBACK,RUNNING> mtu 65536 inet 127.0.0.1 netmask 255.0.0.0 inet6 ::1 prefixlen 128 scopeid 0x10<host> loop txqueuelen 1000 (Local Loopback) RX packets 254 bytes 20458 (20.4 KB) RX errors 0 dropped 0 overruns 0 frame 0 TX packets 254 bytes 20458 (20.4 KB) TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0ホストOSのIPも確認し、通信可能なI/Fは上から2つ目の「enp0s8」、IPが「192.168.56.101」になります。

割愛しますが、ホストOSとゲストOSで「共通のIPではない方のIP」でsshできます。

詳細の説明は、Virtualboxのドキュメントを探して参照してみて下さい。ホストOS(MacOS)のIP確認

enp0s3: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500 inet 10.0.2.15 netmask 255.255.255.0 broadcast 10.0.2.255 inet6 fe80::3306:660:8dc9:8a3e prefixlen 64 scopeid 0x20<link> ether 08:00:27:e9:85:d9 txqueuelen 1000 (Ethernet) RX packets 19768 bytes 19016712 (19.0 MB) RX errors 0 dropped 0 overruns 0 frame 0 TX packets 7290 bytes 490675 (490.6 KB) TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0 enp0s8: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500 inet 192.168.56.101 netmask 255.255.255.0 broadcast 192.168.56.255 inet6 fe80::ff08:5ca7:204b:8b9c prefixlen 64 scopeid 0x20<link> ether 08:00:27:88:8e:37 txqueuelen 1000 (Ethernet) RX packets 208 bytes 25051 (25.0 KB) RX errors 0 dropped 0 overruns 0 frame 0 TX packets 196 bytes 27251 (27.2 KB) TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0 lo: flags=73<UP,LOOPBACK,RUNNING> mtu 65536 inet 127.0.0.1 netmask 255.0.0.0 inet6 ::1 prefixlen 128 scopeid 0x10<host> loop txqueuelen 1000 (Local Loopback) RX packets 267 bytes 21659 (21.6 KB) RX errors 0 dropped 0 overruns 0 frame 0 TX packets 267 bytes 21659 (21.6 KB) TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0Macからsshしてみます。

tagucchan@tagvirtualbox01:~$ ssh tagucchan@192.168.56.101 The authenticity of host '192.168.56.101 (192.168.56.101)' can't be established. ECDSA key fingerprint is SHA256:rgLFPu10ZCNlOSnLROddIRtxfxYtqkzn38auX/c1rmk. Are you sure you want to continue connecting (yes/no)? yes Warning: Permanently added '192.168.56.101' (ECDSA) to the list of known hosts. tagucchan@192.168.56.101's password: Welcome to Ubuntu 18.04.4 LTS (GNU/Linux 5.3.0-42-generic x86_64) * Documentation: https://help.ubuntu.com * Management: https://landscape.canonical.com * Support: https://ubuntu.com/advantage * Canonical Livepatch is available for installation. - Reduce system reboots and improve kernel security. Activate at: https://ubuntu.com/livepatch 11 個のパッケージがアップデート可能です。 0 個のアップデートはセキュリティアップデートです。 Your Hardware Enablement Stack (HWE) is supported until April 2023. Last login: Tue Mar 24 10:58:01 2020 from 192.168.56.1 tagucchan@tagvirtualbox01:~$ゲストOSのUbntu上にDocker環境を構築

公式ドキュメントdocker docs 「Install using the repository」通りに作業します。

aptがhttps経由でリポジトリを使用できるようにする

必要なパッケージをインストール。

sudo apt-get install \ apt-transport-https \ ca-certificates \ curl \ gnupg-agent \ software-properties-commonDocker’s official GPG key を追加

curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo apt-key add -鍵の指紋(finger print)で正しい鍵かをチェック

の指紋(finger print)を確認

sudo apt-key fingerprint 0EBFCD88以下が表示されればOKです。

「9DC8 5822 9FC7 DD38 854A E2D8 8D81 803C 0EBF CD88」出力例:

tagucchan@tagvirtualbox01:~$ sudo apt-key fingerprint 0EBFCD88 pub rsa4096 2017-02-22 [SCEA] 9DC8 5822 9FC7 DD38 854A E2D8 8D81 803C 0EBF CD88 uid [ unknown] Docker Release (CE deb) <docker@docker.com> sub rsa4096 2017-02-22 [S]リポジトリを追加( ここでは x86_64 / amd64 用 stable )

sudo add-apt-repository \ "deb [arch=amd64] https://download.docker.com/linux/ubuntu \ $(lsb_release -cs) \ stable"DOCKER ENGINE - COMMUNITY のインストール

DOCKER ENGINEのCOMMUNITY(コミュニティエディション)をインストールします。

最新に更新しておきます。

sudo apt-get update sudo apt-get upgradeDOCKER ENGINE - COMMUNITY のインストール

sudo apt-get install docker-ce docker-ce-cli containerd.ioDOCKER ENGINEの動作確認

動作するか hello-world で確認します。

sudo docker run hello-world実行例:

Hello from Docker!

This message shows that your installation appears to be working correctly.

の表示が出ればOKです。tagucchan@tagvirtualbox01:~$ sudo docker run hello-world [sudo] password for tagucchan: Unable to find image 'hello-world:latest' locally latest: Pulling from library/hello-world 1b930d010525: Pull complete Digest: sha256:f9dfddf63636d84ef479d645ab5885156ae030f611a56f3a7ac7f2fdd86d7e4e Status: Downloaded newer image for hello-world:latest Hello from Docker! This message shows that your installation appears to be working correctly. To generate this message, Docker took the following steps: 1. The Docker client contacted the Docker daemon. 2. The Docker daemon pulled the "hello-world" image from the Docker Hub. (amd64) 3. The Docker daemon created a new container from that image which runs the executable that produces the output you are currently reading. 4. The Docker daemon streamed that output to the Docker client, which sent it to your terminal. To try something more ambitious, you can run an Ubuntu container with: $ docker run -it ubuntu bash Share images, automate workflows, and more with a free Docker ID: https://hub.docker.com/ For more examples and ideas, visit: https://docs.docker.com/get-started/ tagucchan@tagvirtualbox01:~$

- 投稿日:2020-03-24T15:28:58+09:00

[Windows] Dockerを使用してMosquittoでMQTTサーバを構築する際に別コンテナにloalhostで接続できるようにする

TL;DR

- Mosquittoを使ってMQTTサーバを立てた際にコンテナ間でlocalhostで接続できないかと調査

- docker-composeでnetwork_modeを「host」にすることでホスト端末と同じIPアドレスにすることで可能とわかった

- GO言語のpaho.mqtt.golangライブラリを使って接続テストを実施

環境

- Windows10

- Docker Desktop 2.2.0.3

- docker-composeはDocker Desktopに同梱

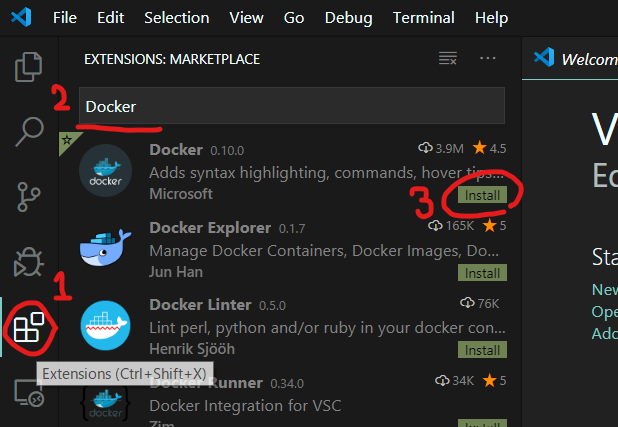

- visual studio code 1.42.1[拡張機能Remote - Containers使用]

- Mosquitto 1.6.9

完成したリポジトリ

https://github.com/MegaBlackLabel/mqtt-docker-sample

ファイル

docker-compose.tmlversion: '3' services: api: build: dockerfile: Dockerfile context: ./containers/api volumes: - ./containers/api/src:/go/api tty: true network_mode: "host" mqtt: build: dockerfile: Dockerfile context: ./containers/mqtt ports: - "1883:1883" volumes: - mosquittodata:/mosquitto/data - mosquittolog:/mosquitto/log tty: true network_mode: "host" volumes: mosquittodata: driver: "local" mosquittolog: driver: "local"

- apiコンテナとmqttコンテナにnetwork_modeで「host」を設定することでホスト端末と同じIPアドレスを使用する

main.gopackage main import ( "crypto/tls" "flag" "fmt" "os" "strconv" "time" MQTT "github.com/eclipse/paho.mqtt.golang" ) // Que Strut. type Que struct { Server string Sendtopic string Resvtopic string Qos int Retained bool Clientid string Username string Password string Client MQTT.Client Callback MQTT.MessageHandler } // Connect func . func (q *Que) Connect() error { connOpts := MQTT.NewClientOptions().AddBroker(q.Server).SetClientID(q.Clientid).SetCleanSession(true) if q.Username != "" { connOpts.SetUsername(q.Username) if q.Password != "" { connOpts.SetPassword(q.Password) } } tlsConfig := &tls.Config{InsecureSkipVerify: true, ClientAuth: tls.NoClientCert} connOpts.SetTLSConfig(tlsConfig) client := MQTT.NewClient(connOpts) if token := client.Connect(); token.Wait() && token.Error() != nil { return token.Error() } q.Client = client if q.Callback != nil { if token := q.Client.Subscribe(q.Resvtopic, byte(q.Qos), q.Callback); token.Wait() && token.Error() != nil { return token.Error() } fmt.Printf("[MQTT] Subscribe to %s\n", q.Sendtopic) } fmt.Printf("[MQTT] Connected to %s\n", q.Server) return nil } // Publish func . func (q *Que) Publish(message string) error { if q.Client != nil { token := q.Client.Publish(q.Sendtopic, byte(q.Qos), q.Retained, message) if token == nil { return token.Error() } fmt.Printf("[MQTT] Sent to %s\n", q.Sendtopic) } return nil } // SetSubscribe - . func (q *Que) SetSubscribe(callback MQTT.MessageHandler) error { if callback != nil { if token := q.Client.Subscribe(q.Resvtopic, byte(q.Qos), callback); token.Wait() && token.Error() != nil { return token.Error() } fmt.Printf("[MQTT] Subscribe to %s\n", q.Sendtopic) } return nil } func onMessageReceived(client MQTT.Client, message MQTT.Message) { fmt.Printf("[MQTT] Received to %s [Received Message: %s]\n", message.Topic(), message.Payload()) } func main() { hostname, _ := os.Hostname() server := flag.String("server", "tcp://localhost:1883", "The full URL of the MQTT server to connect to") sendtopic := flag.String("sendtopic", "MQTT/Client/Update/TEST", "Topic to publish the messages on") resvtopic := flag.String("resvtopic", "MQTT/+/Update/#", "Topic to publish the messages on") qos := flag.Int("qos", 0, "The QoS to send the messages at") retained := flag.Bool("retained", false, "Are the messages sent with the retained flag") clientid := flag.String("clientid", hostname+strconv.Itoa(time.Now().Second()), "A clientid for the connection") username := flag.String("username", "", "A username to authenticate to the MQTT server") password := flag.String("password", "", "Password to match username") flag.Parse() q := &Que{ Server: *server, Sendtopic: *sendtopic, Resvtopic: *resvtopic, Qos: *qos, Retained: *retained, Clientid: *clientid, Username: *username, Password: *password, Callback: onMessageReceived, } err := q.Connect() if err != nil { fmt.Println(err) os.Exit(2) } if err := q.SetSubscribe(onMessageReceived); err != nil { fmt.Println(err) os.Exit(2) } for { time.Sleep(5000 * time.Millisecond) if err := q.Publish("test massage"); err != nil { fmt.Println(err) os.Exit(2) } } }

- MQTTサーバの接続先に「tcp://localhost:1883」を指定しているが、お互いのコンテナがnetwork_modeで「host」を設定しているので接続できる

MQTT接続実行結果

実行結果root@docker-desktop:/go/api# go run main.go go: downloading github.com/eclipse/paho.mqtt.golang v1.2.0 go: downloading golang.org/x/net v0.0.0-20200320220750-118fecf932d8 [MQTT] Subscribe to MQTT/Client/Update/TEST [MQTT] Connected to tcp://localhost:1883 [MQTT] Subscribe to MQTT/Client/Update/TEST [MQTT] Sent to MQTT/Client/Update/TEST [MQTT] Received to MQTT/Client/Update/TEST [Received Message: test massage] [MQTT] Sent to MQTT/Client/Update/TEST [MQTT] Received to MQTT/Client/Update/TEST [Received Message: test massage] [MQTT] Sent to MQTT/Client/Update/TEST [MQTT] Received to MQTT/Client/Update/TEST [Received Message: test massage]まとめ

MQTTサーバをDockerで構築する際にサーバをlocalhostにできないかな、というので調査していてnetwork_mode使えばできることがわかったので記事にしてみました。

- 投稿日:2020-03-24T11:54:06+09:00

Laradockで構築したMySQLの日本語化けを解決

はじめに

LaradockでLaravelの環境構築をしました

ところが、マイグレーションを実行しRegisterを実行しDBを確認したところ

日本語が???と文字化けしてしまっていました

色んな記事を参考に試したものの、どれもうまく行かなかったので

備忘録として残しておきます初期のDBの設定

まずは初期状態のDBの文字コードの設定は下記でした

+--------------------------+----------------------------+ | Variable_name | Value | +--------------------------+----------------------------+ | character_set_client | latin1 | | character_set_connection | latin1 | | character_set_database | utf8 | | character_set_filesystem | binary | | character_set_results | latin1 | | character_set_server | utf8 | | character_set_system | utf8 | | character_sets_dir | /usr/share/mysql/charsets/ | +--------------------------+----------------------------+これをutf8mb4に変更していきます

my.cnfの編集

laradock/mysql/my.cnfを下記に書き換えますmy.cnf# The MySQL Client configuration file. # # For explanations see # http://dev.mysql.com/doc/mysql/en/server-system-variables.html [mysql] [mysqld] skip-character-set-client-handshake character-set-server = utf8mb4 # collation-server = utf8mb4_general_ci collation-server = utf8mb4_unicode_ci init-connect = SET NAMES utf8mb4 [client] default-character-set=utf8mb4database.phpの編集

config/database.phpを下記のように変更します'mysql' => [ 'driver' => 'mysql', 'url' => env('DATABASE_URL'), 'host' => env('DB_HOST', '127.0.0.1'), 'port' => env('DB_PORT', '3306'), 'database' => env('DB_DATABASE', 'forge'), 'username' => env('DB_USERNAME', 'forge'), 'password' => env('DB_PASSWORD', ''), 'unix_socket' => env('DB_SOCKET', ''), 'charset' => 'utf8mb4', //変更 'collation' => 'utf8mb4_unicode_ci', //変更 'prefix' => '', 'prefix_indexes' => true, 'strict' => true, 'engine' => null, 'options' => extension_loaded('pdo_mysql') ? array_filter([ PDO::MYSQL_ATTR_SSL_CA => env('MYSQL_ATTR_SSL_CA'), ]) : [], ]編集はこれで終了

buildする

--buildオプションをつけてコンテナを起動します

下記コマンドを実行$ docker-compose up -d --build workspace nginx mysqlmysqlコンテンに入り文字コードを確認する

mysql> show variables like '%char%'; +--------------------------+----------------------------+ | Variable_name | Value | +--------------------------+----------------------------+ | character_set_client | utf8mb4 | | character_set_connection | utf8mb4 | | character_set_database | utf8 | | character_set_filesystem | binary | | character_set_results | utf8mb4 | | character_set_server | utf8mb4 | | character_set_system | utf8 | | character_sets_dir | /usr/share/mysql/charsets/ | +--------------------------+----------------------------+utf8mb4に変更することができました

DBの文字化けしていた部分を確認すると、日本語で表示されていることが確認できました

- 投稿日:2020-03-24T09:27:04+09:00

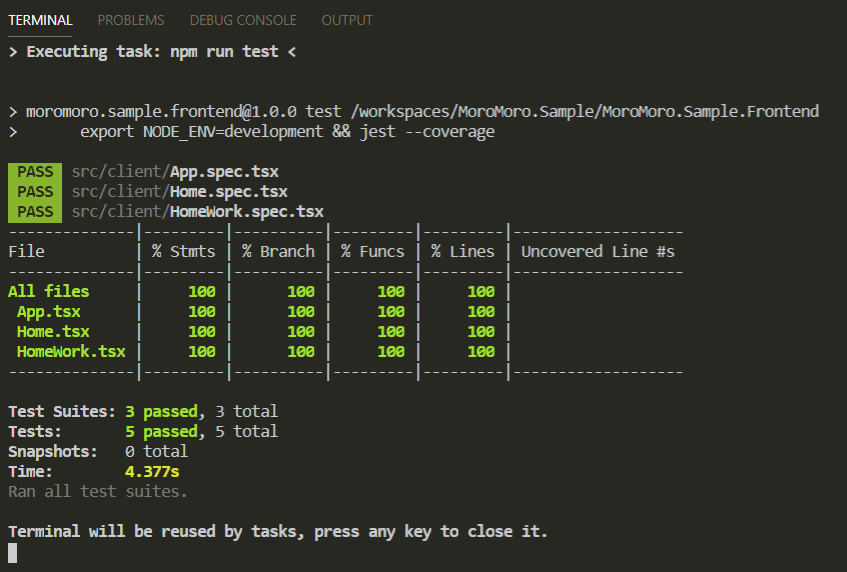

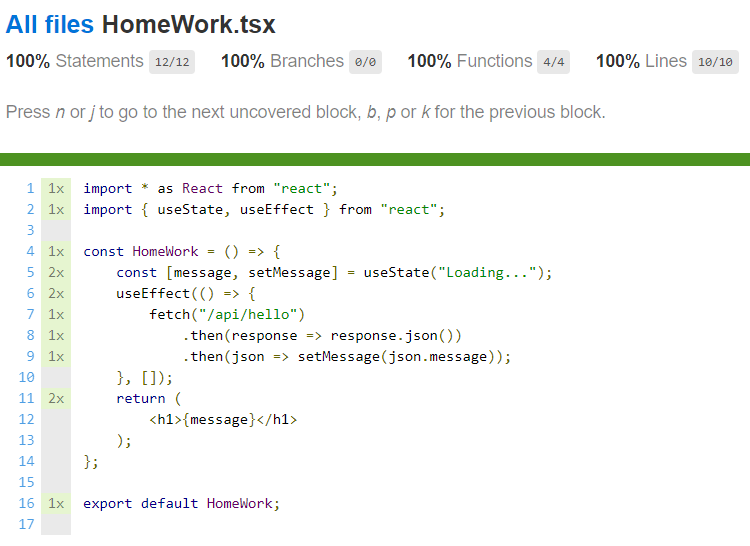

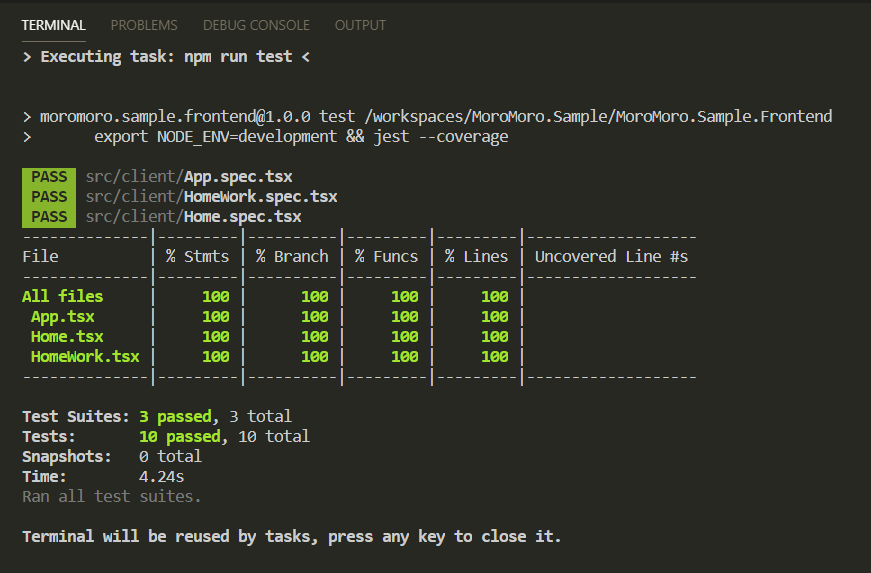

コーディング未経験のPO/PdMのためのRails on Dockerハンズオン、Rails on Dockerハンズオン vol.12 - TDDでPost機能をコーディング part1 -

はじめに

お待たせしました!第12回にしてやっとつぶやき機能を実装してまいります!ここではPost機能といいますね。

前回のソースコード

前回のソースコードはこちらに格納してます。今回のハンズオンからやりたい場合はこちらからダウンロードしてください。

どんなの実装するの?

最初に今回のゴールを見据えておきましょう。

画面遷移

新たにポストページを作ります。

ポストページはポストを投稿するフォームと、今までのユーザー全員のポストが投稿日時降順で表示される機能を具備しています。

ポストページはサインイン済のユーザーしかアクセスできません。

ポストの投稿ユーザーをクリックしたらそのポストのプロフィールページに遷移できます。

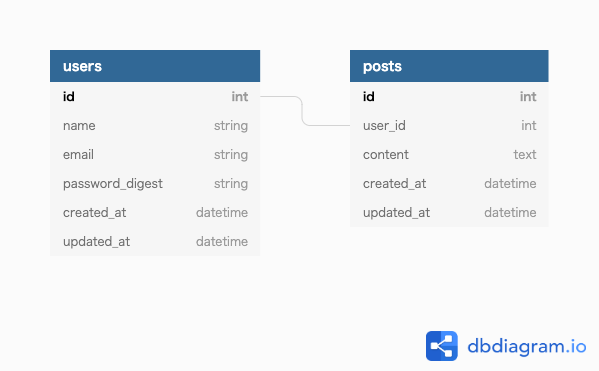

ユーザーのプロフィールページでは、そのユーザーの過去のポストが投稿日時降順で表示されています。ER図

テストシナリオ

さて、これを踏まえて今回のテストシナリオを考えてみましょう。

- 未サインインのユーザーが、ポストページにアクセスしようとしたとき、トップページにリダイレクトされること

- サインイン済のユーザーが、ポストページにアクセスしようとしたとき、ポストページにアクセスできること

- 未サインインのユーザーは、トップページでヘッダーにポストページへのリンクを見つけられないこと

- 未サインインのユーザーは、サインアップページでヘッダーにポストページへのリンクを見つけられないこと

- 未サインインのユーザーは、サインインページでヘッダーにポストページへのリンクを見つけられないこと

- 未サインインのユーザーは、ユーザー詳細ページでヘッダーにポストページへのリンクを見つけられないこと

- サインイン済のユーザーが、プロフィールページでヘッダーのポストリンクをクリックしたとき、ポストページに遷移すること

- サインイン済のユーザーが、ユーザー詳細ページでヘッダーのポストリンクをクリックしたとき、ポストページに遷移すること

- サインイン済のユーザーが、ポストページでヘッダーのポストリンクをクリックしたとき、ポストページに遷移すること

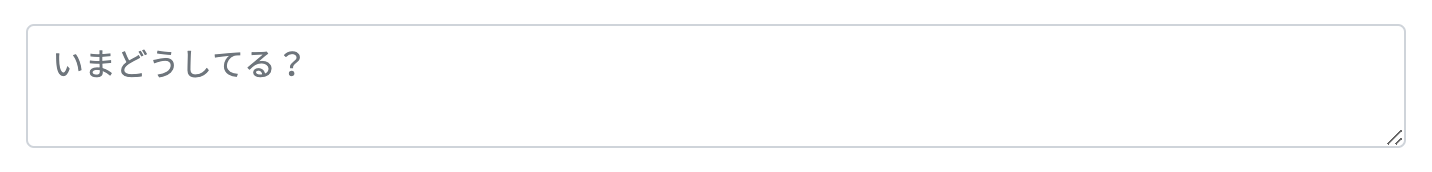

- サインイン済のユーザーは、ポストページでポストを入力できること

- ポストページでポスト未入力のユーザーが、「ポストする」ボタンをクリックしたとき、ポスト投稿は失敗しポスト未入力のエラーメッセージを確認できること

- ポストページでポストを141文字以上入力したユーザーが、「ポストする」ボタンをクリックしたとき、ポスト投稿は失敗しポスト文字数超過のエラーメッセージを確認できること

- ポストページでポストを正しく入力したユーザーが、「ポストする」ボタンをクリックしたとき、ポスト投稿が成功しポスト入力フィールドがクリアされ、ポスト一覧の最上部に投稿したポストを確認できること

- サインイン済のユーザーは、ポストページで全ユーザーのポストを投稿日時降順で閲覧できること

- サインイン済のユーザーが、ポストページでポストのユーザー名をクリックしたとき、そのユーザーのユーザー詳細ページに遷移すること

- 未サインインのユーザーは、ユーザー詳細ページでそのユーザーのポストを投稿日時降順で閲覧できること

- 未サインインのユーザーが、ユーザー詳細ページでそのユーザーのポストのユーザー名をクリックしたとき、何も起こらないこと

- サインイン済のユーザーは、ユーザー詳細ページでそのユーザーのポストを投稿日時降順で閲覧できること

- サインイン済のユーザーが、ユーザー詳細ページでそのユーザーのポストのユーザー名をクリックしたとき、何も起こらないこと

- サインイン済のユーザーは、プロフィールページで自身のポストを投稿日時降順で閲覧できること

- サインイン済のユーザーが、プロフィールページでそのユーザーのポストのユーザー名をクリックしたとき、何も起こらないこと

こんな感じでしょう。

では元気にデベロップしてまいりましょう!今回はTDDで開発をしていくので、テストコードを書いて、アプリコードを書いて、を繰り返していきます。開発スタート

まずは、それぞれのテストシナリオをテストコードに落とし込みましょう。

開発はTDDで進めるので

- テストをコーディングする(Red)

- テストコードがパスするようにアプリケーションをコーディングする(Green)

- 非効率な記述があれば、Greenをキープしながらコーディングし直す(Refectoring)

です。

ではコンテナを起動しておきましょう!

$ docker-compose up -d $ docker-compose exec web ash未サインインのユーザーが、ポストページにアクセスしようとしたとき、トップページにリダイレクトされること

ポストページについては以下の仕様で実装していきます。ポストページのURLパスは

/postsとします。まずはテストコードを書いていきます。今回のテストシナリオ用に新しいテストシナリオファイルを作りましょう。

# touch spec/system/07_posts_spec.rb07_posts_spec.rbfeature "ユーザーとして、ポストを投稿したい", type: :system do scenario "未サインインのユーザーが、ポストページにアクセスしようとしたとき、トップページにリダイレクトされること" do # ポストページにアクセスする visit posts_path # 現在のパスがトップページのパスであることを検証する expect(current_path).to eq root_path end endポストページへのルーティングの名前付きルートを

posts_pathとしています。

今までも何度か書いてきましたが、posts_pathにアクセスしようとしたのに現在のパスはroot_pathです、というリダイレクトの検証です。この時点ではアプリケーションのコーディングを行っていないのでテストは失敗します。

# rspec spec/system/07_posts_spec.rb ... Failures: 1) ユーザーとして、ポストを投稿したい 未サインインのユーザーが、ポストページにアクセスしようとしたとき、トップページにリダイレクトされること Failure/Error: visit posts_path NameError: undefined local variable or method `posts_path' for #<RSpec::ExampleGroups::Nested:0x0000555f60b1ccf8> # ./spec/system/07_posts_spec.rb:3:in `block (2 levels) in <main>' Finished in 2.41 seconds (files took 8.4 seconds to load) 1 example, 1 failure ...RSpecではこのような形でテストの失敗の理由が示されるので、それが解消されるようにアプリケーションをコーディングしていきましょう。

今回はposts_pathという変数もしくはメソッドがアプリケーションに定義されていないことがテスト失敗の理由として示されているので、まずはルーティングの設定をする必要がありそうです。

rails g controllerコマンドでポストページに必要な設定・ファイルを揃えましょう。# rails g controller posts index今回はポストページのためのアクションとして

posts#indexを用意することにしました。

ルーティングを定義します。config/routes.rbRails.application.routes.draw do - get 'posts/index' root 'static_pages#home' get '/sign_up', to: 'users#new', as: :sign_up post '/sign_up', to: 'users#create', as: :create_user resources :users, only: [:show] get '/sign_in', to: 'sessions#new', as: :sign_in post '/sign_in', to: 'sessions#create', as: :create_session delete '/sign_out', to: 'sessions#destroy', as: :sign_out + + get '/posts', to: 'posts#index', as: :posts endこれで名前付きルート

posts_pathが定義されたのでテスト結果が変わるはずです。もう一度テストを実行してみましょう。# rspec spec/system/07_posts_spec.rb Failures: 1) ユーザーとして、ポストを投稿したい 未サインインのユーザーが、ポストページにアクセスしようとしたとき、トップページにリダイレクトされること Failure/Error: expect(current_path).to eq root_path expected: "/" got: "/posts" (compared using ==) # ./spec/system/07_posts_spec.rb:5:in `block (2 levels) in <main>' Finished in 7.94 seconds (files took 16.58 seconds to load) 1 example, 1 failure以前テストは失敗していますが、エラー理由が変わっていますね。

今回は/にリダイレクトされることが期待されていたけど/postsにアクセスできてしまっていることがテスト失敗の理由のようです。

今コントローラーで何も制御をしていないので誰でもポストページにアクセスできてしまいますね。

では、未サインインのユーザーがposts#indexにルーティングされた場合、root_pathにリダイレクトするようにアプリをコーディングしていきましょう!app/controllers/posts_controller.rbclass PostsController < ApplicationController def index # 未サインインの場合、トップページにリダイレクトする + redirect_to root_path unless signed_in? end end以前、サインイン済ならプロフィールページにリダイレクトさせる、という機能を作りましたね。今回はそれの条件が逆バージョンです。

今回使っているunlessはifの逆の分岐です。つまり、trueの場合は何もなし、falseの場合に実行する、という挙動をとります。またテストを実行してみましょう!

# rspec spec/system/07_posts_spec.rb Finished in 4.35 seconds (files took 7.28 seconds to load) 1 example, 0 failuresテストがパスしました!

では次のテストシナリオの実装に移りましょう!サインイン済のユーザーが、ポストページにアクセスしようとしたとき、ポストページにアクセスできること

まずはテストシナリオをコーディングします。

spec/system/07_posts_spec.rbfeature "ユーザーとして、ポストを投稿したい", type: :system do ... + scenario "サインイン済のユーザーが、ポストページにアクセスしようとしたとき、ポストページにアクセスできること" do # テストシナリオ用のユーザーを作成 + user = User.create(name: "John Smith", email: "john@sample.com", password: "john1234") + # サインインページにアクセスする + visit sign_in_path # サインインページで作成したユーザーのメールアドレスを入力する + fill_in :user_email, with: user.email # サインインページで作成したユーザーのパスワードを入力する + fill_in :user_password, with: user.password # サインインボタンをクリックする(サインインする) + click_on :sign_in_button + # ポストページにアクセスする + visit posts_path + # 現在のページがポストページであることを検証する + expect(current_path).to eq posts_path + end end# rspec spec/system/07_posts_spec.rb Finished in 6.5 seconds (files took 13.64 seconds to load) 2 examples, 0 failuresテストがパスしていますね。ちゃんとサインイン前後でリダイレクト機能の出しわけができているようです。

未サインインのユーザーは、トップページでヘッダーにポストページへのリンクを見つけられないこと

こちらもテストから書き始めます。ヘッダーのポストページへのリンクは

header_posts_linkのidを付与することにします。spec/system/07_posts_spec.rbfeature "ユーザーとして、ポストを投稿したい", type: :system do ... + scenario "未サインインのユーザーは、トップページでヘッダーにポストページへのリンクを見つけられないこと" do # トップページにアクセスする + visit root_path + # ページ内に"header_posts_link"をid属性に持つ要素がないことを検証する + expect(page).not_to have_selector "#header_posts_link" + end end# rspec spec/system/07_posts_spec.rb Finished in 7.61 seconds (files took 6.77 seconds to load) 3 examples, 0 failuresまだリンクをコーディングしていないので当然見つからないですね。テストをパスできています。

未サインインのユーザーは、サインアップページでヘッダーにポストページへのリンクを見つけられないこと

一つ前とほぼ同じテストですね。

spec/system/07_posts_spec.rbfeature "ユーザーとして、ポストを投稿したい", type: :system do ... + scenario "未サインインのユーザーは、サインアップページでヘッダーにポストページへのリンクを見つけられないこと" do # サインアップページにアクセスする + visit sign_up_path + # ページ内に"header_posts_link"をid属性に持つ要素がないことを検証する + expect(page).not_to have_selector "#header_posts_link" + end end# rspec spec/system/07_posts_spec.rb Finished in 6.83 seconds (files took 6.03 seconds to load) 4 examples, 0 failures未サインインのユーザーは、サインインページでヘッダーにポストページへのリンクを見つけられないこと

また、ほぼ同じです。

spec/system/07_posts_spec.rbfeature "ユーザーとして、ポストを投稿したい", type: :system do ... + scenario "未サインインのユーザーは、サインインページでヘッダーにポストページへのリンクを見つけられないこと" do # サインインページにアクセスする + visit sign_in_path + # ページ内に"header_posts_link"をid属性に持つ要素がないことを検証する + expect(page).not_to have_selector "#header_posts_link" + end end# rspec spec/system/07_posts_spec.rb Finished in 9.04 seconds (files took 6.57 seconds to load) 5 examples, 0 failuresどんどん進みましょう。

未サインインのユーザーは、ユーザー詳細ページでヘッダーにポストページへのリンクを見つけられないこと

ほぼ同じテストケース最後です。ユーザー詳細ページなので、Userモデルが1つ必要なのですが、前のテストでも

John Smithをcreateしたテストケースがありました。

これを簡易に使いまわせるようにJohn Smithを作成するコードをメソッド化してみましょう。メソッド化はとてもシンプルなRubyコードでdefを使うだけです。メソッド外で変数を使うことになるのでインスタンス変数を使う必要があります。spec/system/07_posts_spec.rb# ユーザー「John Smith」をDBに作成する + def create_john + User.create(name: "John Smith", email: "john@sample.com", password: "john1234") + end feature "ユーザーとして、ポストを投稿したい", type: :system do ... scenario "サインイン済のユーザーが、ポストページにアクセスしようとしたとき、ポストページにアクセスできること" do # テストシナリオ用のユーザーを作成 - user = User.create(name: "John Smith", email: "john@sample.com", password: "john1234") + user = create_john ... end endこれでテストがパスするか一度確認しておきましょう。

# rspec spec/system/07_posts_spec.rb Finished in 7.8 seconds (files took 6.24 seconds to load) 5 examples, 0 failuresこれで

John Smithのユーザー作成を単純なメソッド

呼び出しで必要なテストシナリオからのみ呼び出すことができるようになりました!

では今回のテストシナリオを追加していきます。spec/system/07_posts_spec.rbfeature "ユーザーとして、ポストを投稿したい", type: :system do ... + scenario "未サインインのユーザーは、ユーザー詳細ページでヘッダーにポストページへのリンクを見つけられないこと" do # テスト用のユーザーを作成する + user = create_john + # テストユーザーのユーザー詳細ページにアクセスする + visit user_path(user) + # ページ内に"header_posts_link"をid属性に持つ要素がないことを検証する + expect(page).not_to have_selector "#header_posts_link" + end end# rspec spec/system/07_posts_spec.rb Finished in 8.91 seconds (files took 6.91 seconds to load) 6 examples, 0 failures今回もテストをパスできていることがわかります。メソッド

の呼び出しもうまくいっていますね。サインイン済のユーザーが、プロフィールページでヘッダーのポストリンクをクリックしたとき、ポストページに遷移すること

次はサインイン後にヘッダーにポストページへのリンクが表示されており、クリックするとポストページに行けるようになる機能を作っていきます。今までと同様に、テストからコーディングしていきましょう。

サインイン済のユーザーでテストをするシナリオは前にもあったので、まずはサインイン済の状態にする操作をメソッド化してみます。spec/system/07_posts_spec.rb... # 与えられたユーザーでサインインする + def sign_in(user) # サインインページにアクセスする + visit sign_in_path # サインインページで作成したユーザーのメールアドレスを入力する + fill_in :user_email, with: user.email # サインインページで作成したユーザーのパスワードを入力する + fill_in :user_password, with: user.password # サインインボタンをクリックする(サインインする) + click_on :sign_in_button + end ... feature "ユーザーとして、ポストを投稿したい", type: :system do ... scenario "サインイン済のユーザーが、ポストページにアクセスしようとしたとき、ポストページにアクセスできること" do user = create_john - visit sign_in_path - fill_in :user_email, with: user.email - fill_in :user_password, with: user.password - click_on :sign_in_button + sign_in(user) ... end ... end再度、メソッド化してもテストがパスするかを確認します。

# rspec spec/system/07_posts_spec.rb Finished in 8.96 seconds (files took 8 seconds to load) 6 examples, 0 failuresメソッド化成功です!

ではこのメソッドを使って、今回のテストコードを記述してみます。spec/system/07_posts_spec.rbfeature "ユーザーとして、ポストを投稿したい", type: :system do ... + scenario "サインイン済のユーザーが、プロフィールページでヘッダーのポストリンクをクリックしたとき、ポストページに遷移すること" do # テスト用のユーザーを作成する + user = create_john # テスト用のユーザーでサインインする + sign_in(user) + # プロフィールページにアクセスする + visit user_path(user) # "header_posts_link"をid属性に持つ要素(=ヘッダーのポストリンク)をクリックする + click_on :header_posts_link + # 現在のページがポストページであることを検証する + expect(current_path).to eq posts_path + end endはい。これでテストを回してみましょう。まだヘッダーにポストリンクを作っていないのでRedになるはずです。

# rspec spec/system/07_posts_spec.rb Failures: 1) ユーザーとして、ポストを投稿したい After sign in サインイン済のユーザーが、プロフィールページでヘッダーのポストリンクをクリックしたとき、ポストページに遷移すること Failure/Error: click_on :header_posts_link Capybara::ElementNotFound: Unable to find link or button :header_posts_link Finished in 11.92 seconds (files took 6.78 seconds to load) 7 examples, 1 failure

header_posts_linkをクリックしようとしたけどそんな要素見つからなかった、という失敗理由が表示されていますね。

サインイン後のリンクにポストリンクを追加してあげましょう。app/views/layouts/application.html.erb<% if signed_in? %> + <li class="nav-item"><%= link_to "Posts", posts_path, class: "nav-link", id: :header_posts_link %></li> <li class="nav-item"><%= link_to "Profile", current_user, class: "nav-link", id: :header_profile_link %></li> <li class="nav-item"><%= link_to "Sign out", sign_out_path, method: :delete, class: "nav-link", id: :header_sign_out_link %></li> <% else %>1行、ポストページへのリンクを追加しました。

# rspec spec/system/07_posts_spec.rb Finished in 10.38 seconds (files took 6.17 seconds to load) 7 examples, 0 failures今回はテストがパスしています。今まで実装もしていなかったのでパスしてた、未サインインユーザーにはポストページへのリンクがヘッダーに表示されないテストもパスしているのでデグレなく機能実装ができましたね。

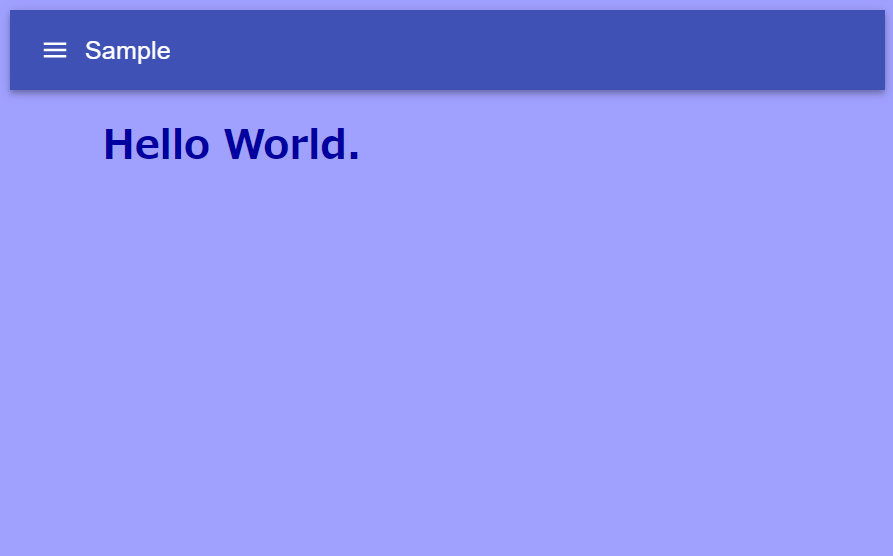

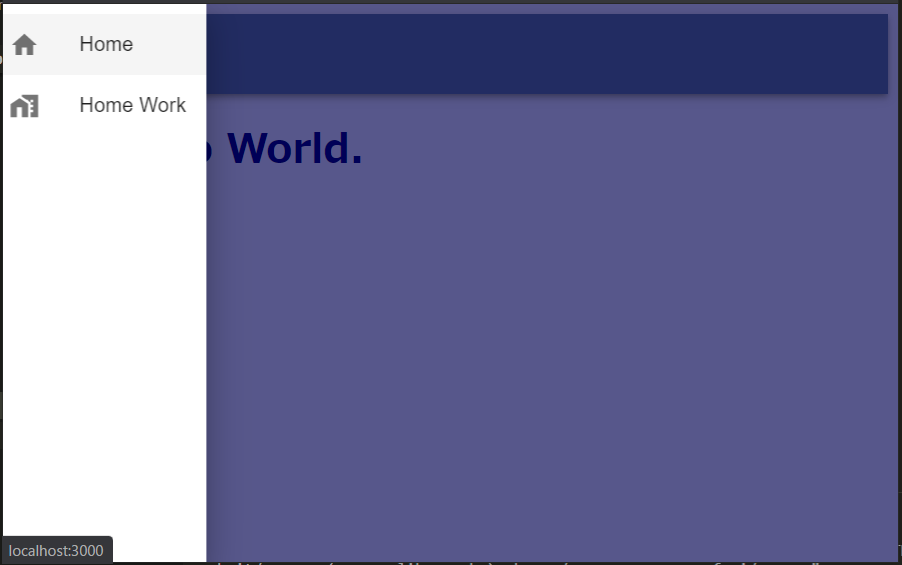

ちょっとViewを確認してみましょう。

Viewを確認してみても、Postsリンクが追加されたことがわかりますね。サインイン済のユーザーが、ユーザー詳細ページでヘッダーのポストリンクをクリックしたとき、ポストページに遷移すること

サインインしているユーザーとは別のユーザーを作成し、そのユーザーのユーザー詳細ページからのポストページへの遷移をテストしてみましょう。

別のユーザーも他のテストシナリオでも使えるようにメソッド化しておきたいところです。create_johnメソッドを少し改良して、引数によって異なるユーザーをDB作成できるように改良して使ってみましょう。spec/system/07_posts_spec.rb- def create_john - User.create(name: "John Smith", email: "john@sample.com", password: "john1234") - end # user_typeに応じて、ユーザーをDBに作成する # 1: John Smith # 2: Taro Tanaka + def create_user(user_type = 1) + case user_type + when 1 + User.create(name: "John Smith", email: "john@sample.com", password: "john1234") + when 2 + User.create(name: "Taro Tanaka", email: "taro@sample.com", password: "taro1234") + end + end ... feature "ユーザーとして、ポストを投稿したい", type: :system do ... scenario "サインイン済のユーザーが、ポストページにアクセスしようとしたとき、ポストページにアクセスできること" do - user = create_john + user = create_user(1) ... end ... scenario "未サインインのユーザーは、ユーザー詳細ページでヘッダーにポストページへのリンクを見つけられないこと" do - user = create_john + user = create_user(1) ... end ... scenario "サインイン済のユーザーが、プロフィールページでヘッダーのポストリンクをクリックしたとき、ポストページに遷移すること" do - user = create_john + user = create_user(1) ... end end

create_userメソッドではcase文を使ってみました。case文はある変数の値に応じて動作を変える分岐を作ることができます。case target when value1 # target == value1 の場合のコード when value2 # target == value2 の場合のコード ... else # どれにも当てはまらなかった場合のコード endでは、メソッドがうまく置き換われたかを確認してみます。

# rspec spec/system/07_posts_spec.rb Finished in 9.62 seconds (files took 6.84 seconds to load) 7 examples, 0 failuresちゃんとテストがパスしていますので、新しいメソッドは機能しています。

ではこのメソッドを使って二人のユーザーを作成して実行するテストコードを記述してみましょう。spec/system/07_posts_spec.rbfeature "ユーザーとして、ポストを投稿したい", type: :system do ... + scenario "サインイン済のユーザーが、ユーザー詳細ページでヘッダーのポストリンクをクリックしたとき、ポストページに遷移すること" do # テスト用のユーザーを2人作成する + user1 = create_user(1) + user2 = create_user(2) # user1でサインインする + sign_in(user1) + # user2のユーザー詳細ページにアクセスする + visit user_path(user2) # "header_posts_link"をid属性に持つ要素(=ヘッダーのポストリンク)をクリックする + click_on :header_posts_link + # 現在のページがポストページであることを検証する + expect(current_path).to eq posts_path + end ... endテストを実行してみましょう。

# rspec spec/system/07_posts_spec.rb Finished in 12.04 seconds (files took 5.41 seconds to load) 8 examples, 0 failures問題なくGreenです。

サインイン済のユーザーが、ポストページでヘッダーのポストリンクをクリックしたとき、ポストページに遷移すること

これも一つ前と同じようなケースです。

spec/system/07_posts_spec.rbfeature "ユーザーとして、ポストを投稿したい", type: :system do ... + scenario "サインイン済のユーザーが、ポストページでヘッダーのポストリンクをクリックしたとき、ポストページに遷移すること" do # テスト用のユーザーを1人作成する + user = create_user(1) # userでサインインする + sign_in(user) + # ポストページにアクセスする + visit posts_path # "header_posts_link"をid属性に持つ要素(=ヘッダーのポストリンク)をクリックする + click_on :header_posts_link + # 現在のページがポストページであることを検証する + expect(current_path).to eq posts_path + end ... end# rspec spec/system/07_posts_spec.rb Finished in 13.63 seconds (files took 6.56 seconds to load) 9 examples, 0 failures遷移系はここまでですね。全てGreenをキープしています。

サインイン済のユーザーは、ポストページでポストを入力できること

いよいよポストページの機能に入っていきます。

でもやり方は変わりません。まずはテストをコーディングしましょう!spec/system/07_posts_spec.rbfeature "ユーザーとして、ポストを投稿したい", type: :system do ... + scenario "サインイン済のユーザーは、ポストページでポストを入力できること" do # テスト用のユーザーを作成する + user = create_user(1) # このテストシナリオで使うポスト内容を定義する + content = "Hello world." # userでサインインする + sign_in(user) + # ポストページにアクセスする + visit posts_path # ポスト入力欄(#post_content)にcontentを入力する + fill_in :post_content, with: content + # ポスト入力欄(#post_content)にcontentが入力されていることを検証する + expect(find("#post_content").value).to eq content + end ... end前回のハンズオンでも出てきた入力してちゃんと入力できているかを確認するテストコードですね。