- 投稿日:2020-02-28T21:03:14+09:00

【Rails】Rails6系とMySQL8系の組み合わせの開発環境をDockerだけでつくる

概要

この記事は弊社ァ内で行った準備作業の備忘録メモでございますわっ

- 次の新規案件に備え、RubyとRails最新版のスケルトン(?)なプロジェクトを準備する

- 各バージョンは以下の予定

- Ruby2.7系

- Rails6.0系

- MySQL8.0系

- Nginx1.17系

- redis(いちおう)

- Docker前提です

- 新規ならDockerでしょ?って、僕も過激派になっている感。

- AWS ECSでの運用が前提のため。

Rubyのイメージはalpine3.11を使用。カーネル5.4系でセキュリティも向上してるらしい(?)し、軽いし1、

$ docker images REPOSITORY TAG IMAGE ID CREATED SIZE ruby 2.7-slim-buster b913dc62d63c 10 days ago 149MB ruby 2.7-buster 0c1ee6efe061 10 days ago 842MB ruby 2.7-alpine3.10 78005ca97a7f 2 weeks ago 52.9MB ruby 2.7-alpine3.11 1f7033feacdb 3 weeks ago 53.5MBdocker-compose化する。最終的にはね。

- そこだけ読みたいならここまでスクロール

やりたいこと

- 作業PC的な観点で

PCローカル内のモダンな過去プロジェクトを汚さずに環境構築したい。PCローカル内のレガシーな過去プロジェクトを汚さずに環境構築したい。- PCローカル内のヴィンテージな過去プロジェクトを汚さずに環境構築したい。

- PC内のパッケージに悪影響が出ないようにしたい。

rails newすらもDockerの中でやりたい。- dockerコンテナ落としてもDBの内容やbundleのgemが消えないようにしたい。

- 他の開発者(後輩くん)が使える程度のものを残しておきたい。

- 運用想定的な観点で(

何様)

- 環境作成

- AP,DBコンテナの構成で十分

rails newしてソースコード準備したい- できれば動作確認したい

- 開発環境(弊社ァ内エンジニア用)

- WEB,AP,DBコンテナに加えてRedisも建てたい

- ↑↑環境差異による不具合を減らすため、本番環境にできるだけ合わせたい・・・!!(切実)

- docker-compose化しておいて、少しでも普段遣いのコマンドを減らしたい

- 本番環境

- AWS ECSで動かす想定

- dockerイメージはできるだけ開発環境そのままECRにプッシュする

- 環境変数だけで環境変えたいよね

- ECSタスク定義とかRDS設定はdocker-compose見ればほぼ設定できるようにしておきたい

Railsプロジェクトの新規作成

目的

- docker内で

rails newしてWebアプリケーションのソースを用意する- ここの見出しでやるのは

rails newだけ。開発環境整える方法は次の見出しまでスクロールしてねやることを決める

- dockerボリュームの有効活用

- 環境構築途中で失敗してもdbとgemを消さないようにして時短。

- dockerのマウントタイプは

bindでわなくvolumeを使う2。Macのファイルシステムへのマウントは遅い(?)ので- 動作確認のためDBコンテナも建てる

事前準備

docker network(一時) を作成

$ # host OS (local PC) $ # コンテナ間通信用のネットワークを用意しておく $ $ APP_NETWORK=tmp_network # 名前をきめてね $ $ docker network create ${APP_NETWORK} $ $ # 確認しよう $ docker network ls NETWORK ID NAME DRIVER SCOPE c31a38da01e0 tmp_network bridge localdocker volume(一時) を作成

$ # host OS (local PC) $ # DBデータ保持用と、gem保存用の2つのdockerボリュームを作っておく。 $ $ DB_VOLUME=tmp_dbdata_vol # 名前をきめてね $ BUNDLE_VOLUME=tmp_bundle_vol # 名前をきめてね $ $ docker volume create ${DB_VOLUME} $ docker volume create ${BUNDLE_VOLUME} $ $ # 確認しよう $ docker volume ls DRIVER VOLUME NAME local tmp_bundle_vol local tmp_dbdata_vol

- これ以降のコンテナ作成作業中で、エラーが出まくったら、volumeを一度作り直すなどして問題解決していこうかと考えていた。

コンテナの作成

DBコンテナ(一時)を建てる

mysqldコマンドのオプションで色々宣言している。**.cnfを用意するのでも良かったけど、本番はRDS使うだろうし、$ # host OS (local PC) $ $ # パスワードはあくまで一例。ちゃんと毎回違うランダム文字を使う癖をつけるように教えるの() $ docker run \ --detach \ --env MYSQL_ROOT_PASSWORD=4h%zpW8wrb+G \ --env TZ="Asia/Tokyo" \ --mount type=volume,source=${DB_VOLUME},target=/var/lib/mysql \ --name tmp_db_mysql \ --network ${APP_NETWORK} \ --publish 127.0.0.1:13306:3306 \ --tty \ mysql:8.0 \ mysqld \ --block_encryption_mode aes-256-cbc \ --character_set_server utf8mb4 \ --collation-server utf8mb4_bin \ --default-authentication-plugin mysql_native_password \ --explicit_defaults_for_timestamp \ --init-connect 'SET NAMES utf8mb4' \ --skip-character-set-client-handshakeAPコンテナ(一時)を建てる

$ # host OS (local PC) $ $ # DBパスワードはDBコンテナと同じもの $ docker run \ --detach \ --env APP_DATABASE_PASSWORD=4h%zpW8wrb+G \ --mount type=volume,source=${BUNDLE_VOLUME},target=/usr/local/bundle \ --name tmp_ap_rails \ --network ${APP_NETWORK} \ --publish 127.0.0.1:3000:3000 \ --tty \ --workdir /app \ ruby:2.7-alpine3.11プロジェクトの新規作成

Railsプロジェクトを新規作成

$ # host OS (local PC) $ $ docker exec -it tmp_ap_rails sh /app # # guest OS (ruby:2.7-alpine3.11) /app # /app # # 必要そうなパッケージをAlpineLinuxPackagesからインストール /app # apk update /app # apk upgrade /app # apk add --update --no-cache \ build-base \ git \ imagemagick \ imagemagick-dev \ libxml2-dev \ libxslt-dev \ mysql-client \ mysql-dev \ nodejs \ ruby-dev \ tzdata \ yarn /app # /app # # yarnのインストールコマンドを叩いておく /app # yarn install

- ローカルPC内でGemfileを作って、それをAPコンテナ(一時)にコピーする

- ここでrailsのバージョンを決めている

Gemfilesource 'https://rubygems.org' git_source(:github) { |repo| "https://github.com/#{repo}.git" } gem 'rails', '~> 6.0', '>= 6.0.2.1'$ # host OS (local PC) $ $ # cpコマンドでdocker内にファイルをコピーする $ docker cp Gemfile tmp_ap_rails:/app/Gemfile$ # host OS (local PC) $ $ docker exec -it tmp_ap_rails sh /app # # guest OS (ruby:2.7-alpine3.11) /app # /app # # railsをインストールする /app # bundle install /app # /app # rails --version Rails 6.0.2.1 /app # /app # # Railsプロジェクトを新規作成する(各オプションはプロジェクトに応じて変える) /app # rails new . \ --database=mysql \ --force \ --skip-coffee \ --skip-sprockets \ --skip-turbolinks \ --skip-test \ --webpack=vue設定値の書き換え

/app # # guest OS (ruby:2.7-alpine3.11) /app # /app # # development と test の設定を変更 /app # vi config/database.ymlconfig/database.yml# --- L20..L24 development: <<: *default database: app_development password: <%= ENV['APP_DATABASE_PASSWORD'] %> host: tmp_db_mysql # --- L29..L33 test: <<: *default database: app_test password: <%= ENV['APP_DATABASE_PASSWORD'] %> host: tmp_db_mysql動作確認

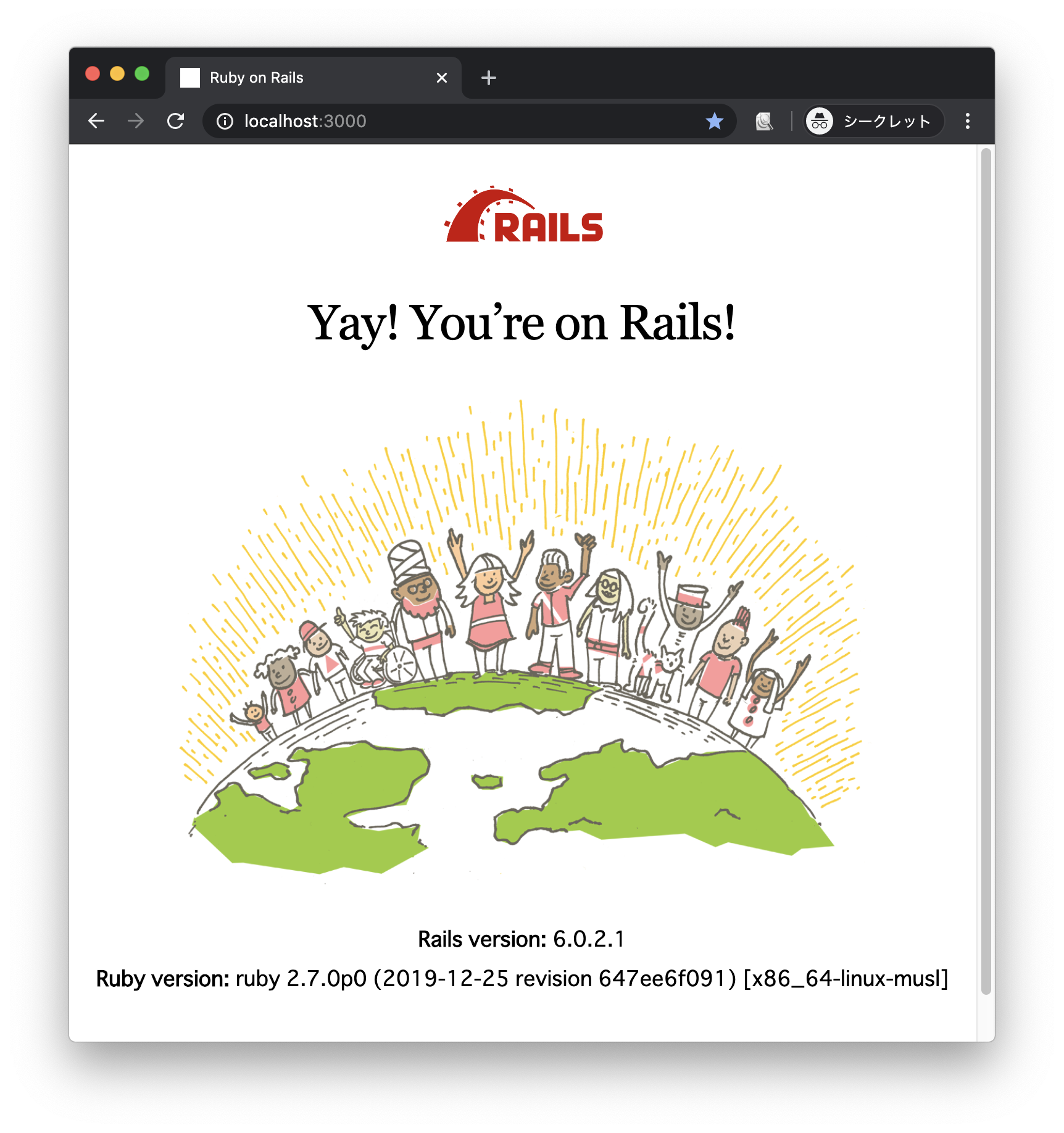

/app # # guest OS (ruby:2.7-alpine3.11) /app # /app # rails db:create /app # /app # rails server -b 0.0.0.0

- ローカルPCで http://localhost:3000 にアクセス

- うまく、いった、みたい、

ソースコードのコピー

- ディレクトリ内をコピーするときは

.をつけるらしい3。- この作業で新規プロジェクトのソースコードがローカルPCにコピーされるので、これをgithubで管理するなりしておく

$ # host OS (local PC) $ $ # Docker内のソースコードをホスト側にコピーする $ docker cp tmp_ap_rails:/app/. ./ゴミ掃除

APコンテナ(一時)の削除

- APコンテナ(一時)は

rails newと動作確認のためだけのコンテナだったので、消す。$ # host OS (local PC) $ $ docker stop tmp_ap_rails $ docker rm tmp_ap_rails $ $ # 消えていることを確認 $ docker ps -aDBコンテナ(一時)の削除

- DBコンテナ(一時)も、消す。

$ # host OS (local PC) $ $ docker stop tmp_db_mysql $ docker rm tmp_db_mysql $ $ # 消えていることを確認 $ docker ps -adocker network(一時)の削除

- docker network(一時)も、消す。

$ # host OS (local PC) $ $ docker network rm ${APP_NETWORK} $ $ # 消えていることを確認 $ docker network lsdocker volume(一時)の削除

- docker volume(一時)も、消す。

$ # host OS (local PC) $ $ docker volume rm ${DB_VOLUME} $ docker volume rm ${BUNDLE_VOLUME} $ $ # 消えていることを確認 $ docker volume lsRailsプロジェクトの新規作成まとめ

- 長文になってしまって申し訳ナソス

- ローカルPCのrubyバージョンに影響されずにrailsプロジェクトが新規作成できた。

- (rbenvとかを使用してもこの程度はできる気がするけど・・・)

- これを応用してエンジニア用の開発環境も整えていく形で良さそう。(何様)

- 上記に記してはいないが、volume設定でgemを別に保持できていたのを確認できているので、感触はOK

- 直接volume内を見に行くのは少々面倒だが、bindよりは動作速そう(?)。

docker-compose化

目的

- ここから先が本当にやりたかったことやで。。。

- 上記までの準備(新規作成したrailsプロジェクト)をもとに、開発環境(弊社ァ内エンジニア用)を整えてゆく

やることを決める

docker-compose.ymlを用意する- 基本

docker-compose up -d,docker-compose downコマンドだけで動くようにしておく- ログローテートはちゃんと設定する(もし無限ログ吐き出されてもPCをパンクさせない教訓)

- Dockerfileの用意をしてビルド時には必要パッケージがインストールされている状態にする

- Dockerfileはマルチステージビルド4を仕込んでおき、本番リリースに使えるようにしておく

- WEBコンテナ(nginx)を追加して、静的ページを表示できるようにする

- 静的ファイル、ソケットはAPコンテナとつなげておく

- ソケットはrails6だからpuma(unixソケットにする予定)

- 起動順の依存関係には一番最後

- CACHEコンテナ(redis)を追加しておく

- 起動順の依存関係はAPより前

- 今回は使わないけど。開発で使うので

Dockerfileの作成

containers/web/DockerfileFROM nginx:1.17-alpine LABEL maintainer="なまえ <メアド>" # 設定ファイルを上書き RUN rm -f /etc/nginx/conf.d/* ADD ./containers/web/default.conf /etc/nginx/conf.d/default.conf # nginxの起動 CMD /usr/sbin/nginx -g 'daemon off;' -c /etc/nginx/nginx.confcontainers/web/default.conf# @note ホストサーバーとのファイル共有は以下 # - tmp/ # pumaソケット通信用 # - public/ # rails静的ファイル共有(404ページとかjs,cssとか) # nginxとpumaのソケット通信の設定 # @see{https://github.com/puma/puma/blob/master/docs/nginx.md} upstream rails_app { server unix:///rails_app/tmp/sockets/puma.sock; } server { listen 80; server_name localhost; # HTTPの持続的な接続維持時間(軽量なので0秒(off)でもいいかも) keepalive_timeout 5; # アップロードサイズの上限を設定 client_max_body_size 10m; # 静的ファイルのパス root /rails_app/public; # ログ出力(dockerイメージの設定より、このパスは標準出力となる) access_log /var/log/nginx/access.log; error_log /var/log/nginx/error.log info; # メンテナンスファイルが置かれている場合はメンテ画面を出す if (-f $document_root/maintenance.html) { rewrite ^(.*)$ /maintenance.html last; break; } location / { proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header Host $http_host; # 静的ファイル if (-f $request_filename) { break; } if (-f $request_filename/index.html) { rewrite (.*) $1/index.html break; } if (-f $request_filename.html) { rewrite (.*) $1.html break; } if (!-f $request_filename) { proxy_pass http://rails_app; break; } } # 後方一致で画像などの静的ファイルが指定された場合はpublic/配下のファイルを直接返す(Railsを介さない) location ~* \.(ico|css|gif|jpe?g|png|js)(\?[0-9]+)?$ { proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header Host $http_host; # ファイルパスが存在しない場合はRailsで処理 if (!-f $request_filename) { proxy_pass http://rails_app; break; } expires max; break; } }

- ↓↓マルチステージビルドの使い方が完全に自己流なんだけどこれで良いのかしら・・・。

containers/app/DockerfileFROM ruby:2.7-alpine3.11 as dev_mode LABEL maintainer="なまえ <メアド>" # ビルド時の作業ディレクトリ WORKDIR /app # AlpineLinuxPackagesで必要そうなコマンドをインストール RUN apk update && \ apk upgrade && \ apk add --update --no-cache \ build-base \ git \ imagemagick \ imagemagick-dev \ libxml2-dev \ libxslt-dev \ mysql-client \ mysql-dev \ nodejs \ ruby-dev \ tzdata \ yarn # yarnインストールの実行(先にlockファイルをコピーしてバージョンを固定) COPY package.json yarn.lock ./ RUN yarn install # マルチステージビルドで本番用イメージを作成 FROM dev_mode as prod_mode # Railsの秘密情報のマスターキー(docker build時にオプションで宣言する) ARG RAILS_MASTER_KEY ENV RAILS_MASTER_KEY ${RAILS_MASTER_KEY} # 本番モードで起動する ENV RAILS_ENV production # アプリのソースをイメージ内にコピー COPY ./ ./ RUN bundle install # フロント用のライブラリのインストールと静的ファイルの作成 RUN rails yarn:install RUN rails webpacker:compile # コンパイル後、マスターキー情報はイメージから消しておく ENV RAILS_MASTER_KEY=docker-compose.ymlの作成

- 2020/02くらいに確認したときは、バージョン3.7が最新だった5ので、それで。

- パスワードはあくまで一例。

docker-compose.ymlversion: '3.7' # @see {https://docs.docker.com/compose/compose-file/} services: # DBコンテナの設定 db: # ビルドに使うイメージ image: mysql:8.0 # 環境変数 environment: MYSQL_DATABASE: app_development MYSQL_ROOT_PASSWORD: F-O75%kSG6gz TZ: "Asia/Tokyo" # ログローテート設定 logging: driver: "json-file" options: max-size: "10m" max-file: "3" # コンテナ間通信用 networks: - app_net # ホストOSに開放するポートの指定 ports: - 127.0.0.1:3306:3306 # ファイルのマウント設定 volumes: # データベースの内容をDocker領域に同期する(データ永続化のため) - type: volume source: mysql_data_vol target: /var/lib/mysql # コンテナを永続化 tty: true # 認証を旧式(パスワード)に変更、デフォルトの文字コードとcollate設定を指定、暗号化のモード選択 command: > mysqld --block_encryption_mode aes-256-cbc --character_set_server utf8mb4 --collation-server utf8mb4_bin --default-authentication-plugin mysql_native_password --explicit_defaults_for_timestamp --init-connect 'SET NAMES utf8mb4' --skip-character-set-client-handshake # Redisコンテナの設定 redis: # ビルドに使うイメージ image: redis # ログローテート設定 logging: driver: "json-file" options: max-size: "10m" max-file: "3" # コンテナ間通信用 networks: - app_net # コンテナを永続化 tty: true # APコンテナの設定 app: # ビルド時の設定 build: # プロジェクトのディレクトリでビルドする context: . # マルチステージビルドのターゲットを指定 target: dev_mode # Dockerfileの場所を指定 dockerfile: containers/app/Dockerfile # コンテナ依存関係 depends_on: - db - redis # 環境変数 environment: APP_DATABASE_PASSWORD: F-O75%kSG6gz # RAILS_MASTER_KEY: # RAILS_MAX_THREADS: TZ: "Asia/Tokyo" # ログローテート設定 logging: driver: "json-file" options: max-size: "10m" max-file: "3" # コンテナ間通信用 networks: - app_net # ファイルのマウント設定 volumes: # アプリのソースをホストOSと共有する - type: bind source: . target: /app # gemをDocker領域に同期する - type: volume source: bundle_vol target: /usr/local/bundle # コンテナを永続化 tty: true # bundle install 、yarn install を行い、pumaサーバーを起動する command: > sh -c " bundle install && rails yarn:install && rails webpacker:compile && pumactl start" # WEBコンテナの設定 web: # ビルド時の設定 build: # プロジェクトのディレクトリでビルドする context: . # Dockerfileの場所を指定 dockerfile: containers/web/Dockerfile # コンテナ依存関係 depends_on: - app # ログローテート設定 logging: driver: "json-file" options: max-size: "10m" max-file: "3" # ホストOSに開放するポートの指定 ports: - 127.0.0.1:80:80 # ファイルのマウント設定 volumes: # 静的ファイルの共有 - type: bind source: ./public target: /rails_app/public # pumaソケットファイルの共有 - type: bind source: ./tmp target: /rails_app/tmp # ネットワークの定義 networks: # コンテナ間通信用 app_net: # ボリュームの定義 volumes: mysql_data_vol: bundle_vol:

- rails側のDB設定も修正修正(ホストをdocker-composeで定義した名前に変えよう)

config/database.yml# --- L20..L24 development: <<: *default database: app_development password: <%= ENV['APP_DATABASE_PASSWORD'] %> host: db # --- L29..L33 test: <<: *default database: app_test password: <%= ENV['APP_DATABASE_PASSWORD'] %> host: db

- あと、WEBコンテナとソケット通信させるためにconfigも少し修正が必要だった6

config/puma.rb# --- L13 # unixソケット通信はポートを使用しない # port ENV.fetch("PORT") { 3000 } # --- 最後に追加 # ソケット通信の設定(WORK_DIRを/appにしているからもう直書きで良いかしら) bind "unix:///app/tmp/sockets/puma.sock"動作確認

$ # host OS (local PC) $ $ # いよいよdocker-compose起動するぜ!! $ docker-compose up -d $ $ # 確認 $ docker-compose ps Name Command State Ports ---------------------------------------------------------------------------------------------------- skl_rails6021_app_1 sh -c bundle install && r ... Up skl_rails6021_db_1 docker-entrypoint.sh mysql ... Up 127.0.0.1:3306->3306/tcp, 33060/tcp skl_rails6021_redis_1 docker-entrypoint.sh redis ... Up 6379/tcp skl_rails6021_web_1 /bin/sh -c /usr/sbin/nginx ... Up 127.0.0.1:80->80/tcp $ $ # 確認 $ docker-compose logs --tail 30 app $ docker-compose logs --tail 30 web $ $ # MySQLもローカルPCから接続できるよね $ mysql -u root -p

- ローカルPCで http://localhost:80 にアクセス(初回は時間がかかるのでログを見て落ち着いたら)

- うまく、できた、みたい、

READMEに説明を書く

- やる。

- 僕だけ使えても意味がない。

- もしかしたらこの作業が一番骨折れるかもしれない。

最後に

- 長文失礼。

- ポート開放不親切失礼。必要に応じて書き換え願う

- ruby2.7対応していないgemがいくつかあるみたいで、ログが汚い。

warningの大量発生や。。。(2020/02ころ現在)- WEBコンテナ追加してnginxとソケット通信する作業でに労力増えてる感ある。

rails severのありがたみを感じる。。。- redisの設定は開発時にやるで良いよね。。。

https://hub.docker.com/_/ruby ←←2020/02くらいにここを閲覧した、そして全部取得して比べてみた。 ↩

https://docs.docker.com/storage/volumes/ ←Docker領域内に名前つけて保存されるから、万が一ソースコードごと紛失してもワンチャンある() ↩

https://medium.com/veltra-engineering/how-to-copy-a-directory-using-docker-cp-command-f2c73f9ccf75 ←←こちらのサイトがとても参考になりました

↩

https://docs.docker.com/develop/develop-images/multistage-build/#use-a-previous-stage-as-a-new-stage ↩

https://docs.docker.com/compose/compose-file/compose-versioning/ ↩

https://github.com/puma/puma#binding-tcp--sockets unixソケットにするためにbindのオプションを

config/puma.rbに書く必要があった。こことかこれとかこのへん読んでも書き方迷いそう。。。 ↩

- 投稿日:2020-02-28T19:43:22+09:00

dockerでwordpress環境を構築する

dockerでwordpress環境を構築する

dockerを使ってwordpress環境を構築しました。

前提

- dockerはインストール済み

やったこと

1.wordpress実行用のdocker networkをつくる

docker network create wp-netwp-netとした。

2.作成したwp-netネットワークに参加させる形でmysqlのコンテナを起動する

run --name cp-mysql --network wp-net -e MYSQL_ROOT_PASSWORD=my-secret-pw -d mysql:$(WPの推奨バージョンを指定する)3.2で起動したコンテナのIPアドレスを調べる

docker network inspect wp-net1で起動したコンテナを探してIPv4Addressの値をメモる

4.wp-net上にwordpressのコンテナを起動する。

今回はホストの8080ポートをWebアクセスの入り口としてバインドする

docker run --name wordpress3 --network wp-net -e WORDPRESS_DB_PASSWORD=$(1で指定したDBパスワード) -e WORDPRESS_DB_HOST=$(3でメモったIPアドレス) -p 8080:80 -d wordpress5.ブラウザで開く

http://localhost:8080/

をお好きなブラウザで開く

開いたら成功。めでたしめでたし

- 投稿日:2020-02-28T16:48:55+09:00

初めてのWEBアプリ作成(1)

はじめに

初めまして、RHEMS技術研究室所属の白瀬です。

今回は初めてWEBアプリ作成としてTrello風ToDoリストを作成するまでの工程を投稿していこうと思います。間違った点がありましたらご指摘いただけると嬉しいです。

環境はmacのdocker,iTerms2を使用しています。コンテナ構築

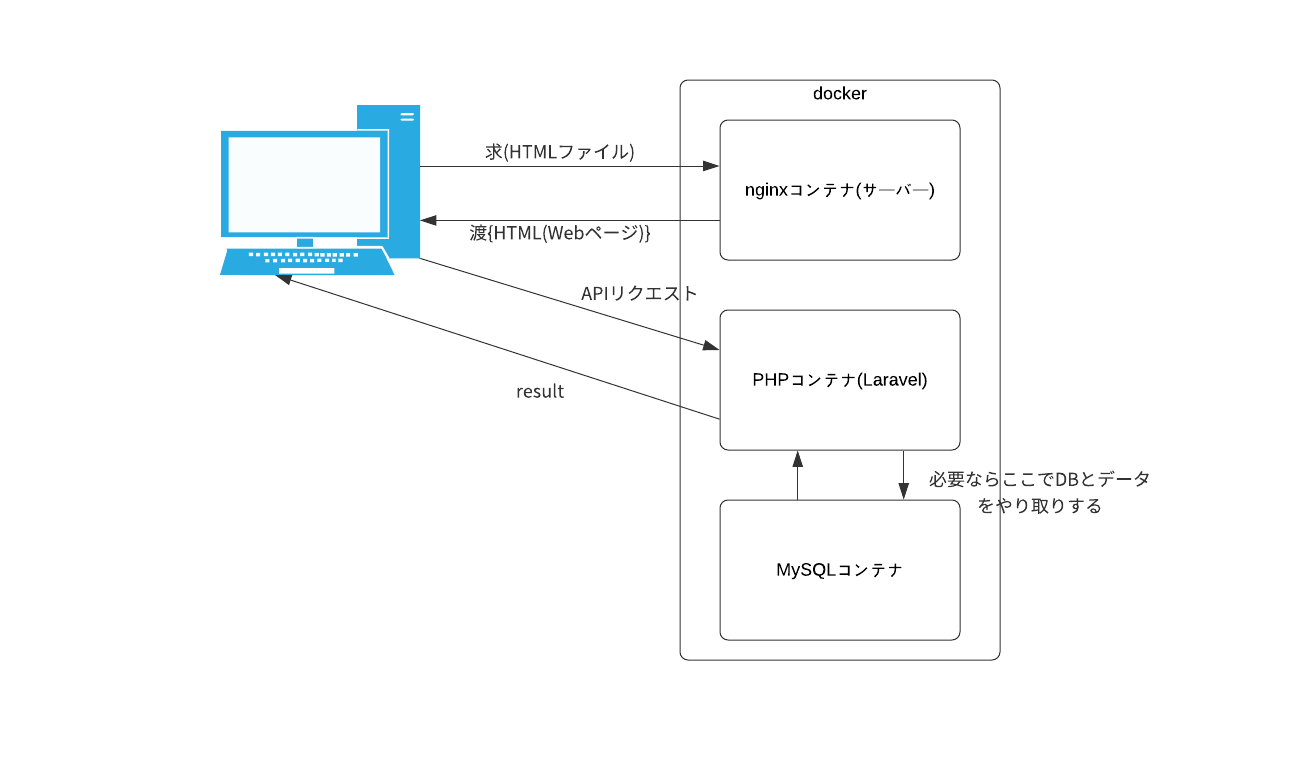

nginx・PHP・MYSQLのコンテナの構築をdockerで行いました。!

今回はnginxとPHPの連携させずに作って行きます。

全体のディレクトリ

├── docker-compose.yml ├── nginx │ └── nginx.conf ├── php │ ├── Dockerfile │ └── php.ini ├── mysql │ └── data └── www └── html └── index.phpコマンド

docker-compose.yml

version: '3' services: nginx: image: nginx:latest ports: - 8080:80 volumes: - ./nginx/nginx.conf:/etc/nginx/conf.d/default.conf - ./www/html:/var/www/html depends_on: - php php: build: ./php volumes: - ./www/html:/var/www/html depends_on: - db db: image: mysql:5.7 ports: - 13306:3306 volumes: - ./mysql/data:/var/lib/mysql environment: MYSQL_ROOT_PASSWORD: secretnginx.conf

server { listen 80; server_name _; root /var/www/html; index index.php index.html; access_log /var/log/nginx/access.log; error_log /var/log/nginx/error.log; location / { try_files $uri $uri/ /index.php$is_args$args; } location ~ \.php$ { fastcgi_pass php:9000; fastcgi_index index.php; fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name; include fastcgi_params; } }Dockerfile

FROM php:7.2-fpm COPY php.ini /usr/local/etc/php/php.ini

date.timezone = "Asia/Tokyo"index.php

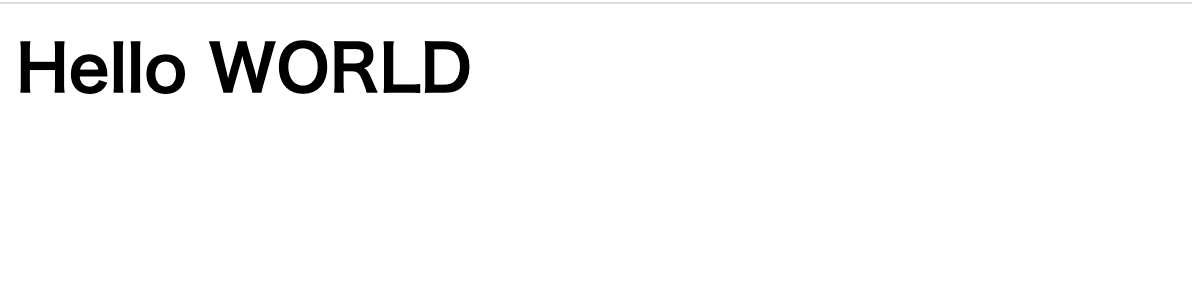

<h1>Hello WORLD</h1>すべて書き終えた後docker-compose.ymlがあるディレクトリまで移動し下記のコマンドを実行

docker-compose up -d実行し終えたらlocalホスト(http://localhost:8080/)に接続して画像のようになりました。

残りはこれをToDoリストように書き換えていくだけだと思っています。あとがき

自分がWEBアプリを作ってみてくれ言われ何をしたらいいか分からずdocker trello 作成などといった検索をかけていましたが的はずれなことをしていました。

誰でもはじめはわからないことばかりなので皆さんも人に聞きましょう。

自分は4日ほど悩んでました…

- 投稿日:2020-02-28T15:43:08+09:00

コンテナ上のpython27/pyodbcでホストのSQL Serverにアクセスする

概要

先日の以下の記事でmysqlにアクセスする方法をご紹介しましたが、

コンテナ上のpython3/mysql-connector-pythonでホストのmysqlにアクセスする

SQL serverバージョンをご紹介します。前提

ホストSQL Server

ODBC Driver 17 for SQL Server

SQLServer認証でポート1443で動作している手順

ODBCが動くDockerコンテナの作り方の記事内にある以下のリポジトリをcloneします。

https://github.com/Microsoft/mssql-docker/tree/master/oss-drivers/pyodbc> git clone https://github.com/microsoft/mssql-docker.git > cd mssql-docker/oss-drivers/pyodbc以下のツリーになっていると思います。

pyodbc ├── Dockerfile ├── README.md ├── docker-compose.yml *docker-composeで立ち上げるために追加 ├── entrypoint.sh └── sample.py *編集します。もしくは別ファイルを作ってもよいです。touch入ってませんが...Dockerfile# mssql-python-pyodbc # Python runtime with pyodbc to connect to SQL Server FROM ubuntu:16.04 # apt-get and system utilities RUN apt-get update && apt-get install -y \ curl apt-utils apt-transport-https debconf-utils gcc build-essential g++-5\ && rm -rf /var/lib/apt/lists/* # adding custom MS repository RUN curl https://packages.microsoft.com/keys/microsoft.asc | apt-key add - RUN curl https://packages.microsoft.com/config/ubuntu/16.04/prod.list > /etc/apt/sources.list.d/mssql-release.list # install SQL Server drivers RUN apt-get update && ACCEPT_EULA=Y apt-get install -y msodbcsql unixodbc-dev # install SQL Server tools RUN apt-get update && ACCEPT_EULA=Y apt-get install -y mssql-tools RUN echo 'export PATH="$PATH:/opt/mssql-tools/bin"' >> ~/.bashrc RUN /bin/bash -c "source ~/.bashrc" # python libraries RUN apt-get update && apt-get install -y \ python-pip python-dev python-setuptools \ --no-install-recommends \ && rm -rf /var/lib/apt/lists/* # install necessary locales RUN apt-get update && apt-get install -y locales \ && echo "en_US.UTF-8 UTF-8" > /etc/locale.gen \ && locale-gen RUN pip install --upgrade pip # install SQL Server Python SQL Server connector module - pyodbc RUN pip install pyodbc # install additional utilities RUN apt-get update && apt-get install gettext nano vim -y # add sample code RUN mkdir /sample ADD . /sample WORKDIR /sample CMD /bin/bash ./entrypoint.shdocker-compose.yamlversion: '3' services: pyodbc: restart: always build: . container_name: 'pyodbc' working_dir: '/sample' tty: true volumes: - .:/sample extra_hosts: - "(ホストのCOMPUTERNAME):(ホストのIPアドレス)" ports: - 1443:1443sample.pyimport pyodbc server = '(ホストのIPアドレス),(ホストのSQLServer動作ポート)' username = 'sa' password = 'password' cnxn = pyodbc.connect('DRIVER={ODBC Driver 17 for SQL Server};SERVER='+server+';database=(データベース名);UID='+username+';PWD='+password) cursor = cnxn.cursor() print ('Using the following SQL Server version:') tsql = "SELECT @@version;" with cursor.execute(tsql): rows = cursor.fetchall() for row in rows: print(str(row))> docker-compose up -d --build ... > docker container ps CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 2c51574bfd36 pyodbc_pyodbc "/bin/sh -c '/bin/ba…" 51 minutes ago Up 51 minutes 0.0.0.0:1443->1443/tcp pyodbc > docker exec -it 2c51574bfd36 /bin/bash $ python --version Python 2.7.12 $ python sample.py Using the following SQL Server version: (u'Microsoft SQL Server 2017 (RTM) - 14.0.1000.169 (X64) \n\tAug 22 2017 17:04:49 \n\tCopyright (C) 2017 Microsoft Corporation\n\tExpress Edition (64-bit) on Windows 10 Pro 10.0 <X64> (Build 18362: ) (Hypervisor)\n', )結果

無事SQL ServerにアクセスしDB参照できました。

後日談(2020/2/28追記内容)

ヒアドキュメントを文字列代入した時にエラー発生

変更内容

sample.pytsql = '''\ SELECT * FROM ~ INNER JOIN ~ ON '''エラー内容

$ python sample.py File "sample.py", line 17 SyntaxError: Non-ASCII character '\xe7' in file sample.py on line 18, but no encoding declared; see http://python.org/dev/peps/pep-0263/ for details File "sample.py", line 54, in <module> with cursor.execute(tsql): UnicodeDecodeError: 'ascii' codec can't decode byte 0xe7 in position 48: ordinal not in range(128)試行した手順

以下の記事で解決しましませんでした。

http://shu223.hatenablog.com/entry/20111201/1328334689以下の記事で解決しませんでした。

https://qiita.com/chatrate/items/eb4b05cd1a6652529fd9解決した手順

以下を参考にしたら解決しました。

https://kaworu.jpn.org/python/Python%E3%81%AEUnicodeDecodeError%E3%81%AE%E5%AF%BE%E5%87%A6%E6%96%B9%E6%B3%95sample.py- with cursor.execute(tsql): + with cursor.execute(tsql.decode('utf-8')):後日談改(2020/2/29追記内容)

ホストのIPアドレス可変に対応

コンテナ内から

host.docker.internalとかいうホストOSに%COMPUTERNAME%さしてくれるエイリアスがあるみたいです。docker-compose.yml- extra_hosts: - - "(ホストのCOMPUTERNAME):(ホストのIPアドレス)"

- 投稿日:2020-02-28T14:19:58+09:00

GitLab-CIで「ERROR: Job failed (system failure): Error: No such container」が発生

現象

GitLab-CIのジョブが、ある日突然下記のようなエラーを吐いて

Failedになるようになった。

この状態では、同じジョブはリトライしても高確率で失敗。(たまに成功しているジョブもあるのが難解)gitlab-runnerはDocker版を使用しており、Docker Executorとしてセットアップしたもの。

ERROR: Job failed (system failure): Error: No such container: 40c002093a4bd596c73a19aa006b80b552d728d76128654cf65f3ac4967fdac3 (executor_docker.go:785:0s)調査

エラー内容で調べていると、この投稿にたどり着いた。

下記のような操作が有効とのこと。

- Dockerのサービスを止める

- すべてのイメージを削除する

- ディスク領域を開放する

- Dockerとgitlab-runnerのサービスを起動する

対処

ディスク領域が逼迫している様子はなかったので、私の場合は2や3は関係ないような気がした。

そのため、とりあえずgitlab-runnerのコンテナを稼働させているVMを再起動させてみることに。

この操作に伴って、上記の1や4の操作を実施することになる。再起動後は、正常に動作していることを確認。

安易に再起動できない環境の場合は、必要に応じて上記1~4の操作を試してみると良さそう。

- 投稿日:2020-02-28T13:39:54+09:00

TDD失敗事例(次回に活きれば)

まとめ

いきなりですが、私がTDDを実施するために必要だと感じたこと(今回足りなかったこと)

1. 詳細設計所(もしくは十分な業務知識の理解。何を作ってるのか?)

2. 単体テストをするための準備(繰り返し実行しても同じ結果が返ること。DB定義の更新があった場合取り込めて、データの作成の手間が最小になるような環境に出来るのが理想。どうやるのがベストなのか、まだわかりません)

3. 体制準備(テストがオールグリーンじゃないとpushできないくらいの強制力のある仕組みを用意してもいいかも)

4.pullrequestの単位を小さくすること(単位がでかすぎると結局どういうコードがあって、どんなテストがされてるのかわからない。初めにテストを書かせて、どんなテストをするかレビューした後にコード実装に入ってもいいかも)なぜTDD?

- 既存のソースコード改修してリリース->予想外の場所でエラーが・・・

- メソッドが長すぎて何やってんのかよくわからん

- とりあえず実装したけどバグがやばい!

↓

こんなときにTDDで開発すればきれいさっぱり解決します!

(今回私は完全に達成できなかったのですが、体感として一部あります。)メリットデメリット(書籍の内容&私が感じたこと)

メリット デメリット 1. メソッドが最小になりやすい。

2.既存のコード改修時に既存の振る舞いに変更がないことを確認しやすい。

3.業務ロジックがわかる(テストを記述するためにはどういうテストが必要か?を知る必要があり、最低限の業務を理解している必要がある)

4.リファクタリングが容易1.コード量が倍になる

2.テストを書きなれていないと時間がかかる(個人差あると思います。)

3.それなりに技術力が必要(どんなテストがあるのか?)

4.既存コードへの適用は大変当たり前かもしれませんが、テストを書いて、ちゃんとグリーンで通ってるよねってことが確認できてもそれが必ずしも業務要件や、パフォーマンス、ユーザビリティを保証しているものではないので、そこは別途注意が必要だと思います。

失敗したこと(こうなって欲しくないこと)

- ソースレビュー時にテスト長すぎてバーがグリーンになるけど結局何やってるかわからない

- 単体テストがかけるレベルの詳細設計所を書けなかった。ざっくりとした要件で伝えてしまったので、テストは全てグリーンになっていたが、業務要件が満たせていなかった。

- 単体テストをする環境作り。個人の環境で何回実行しても同一のテストが繰り返しグリーンになるようなDBおよびテストデータ作りの十分な知見がなく、それをするための環境の整備ができなかった。

- プロジェクトが炎上したときにテストコードを最後まで書ききることができない部分があった。

- 投稿日:2020-02-28T12:48:16+09:00

docker run -it の「-it」とはなにか

Docker, コマンド操作の初心者向けに書いています.

Docker コンテナを起動するとき,

docker run -it ubuntu:18.04 bashと入力したりする……,

-itとはいったい何か, という話です.-it は オプション -i と -t の指定

-itと入力した場合,

-i or --interactiveと-t or --tty2つのオプションを指定したという意味です.(標準化されたものか分かりませんが一般的に)

-iはショートオプション,--interactiveはロングオプション

と呼ばれます.

docker run -it ...とdocker run -i -t ...

この2つの指定は同じです.docker run コマンドに限らず, 多くのコマンドでこういったオプション指定ができるようになってます.

(たとえばgrep. 大文字小文字を無視, ディレクトリ再帰, バイナリを無視を指定する場合のgrep -irIはgrep -i -r -Iと同じ)interactive (-i, --interactive) オプションは入力のこと

interactive オプションは, 「入力」のことです.

もうちょっと具体的には「標準入力」のことです. 次のものが相当します.

- キー入力

- パイプされたデータ

- ファイルからのリダイレクト

例を出します.

「seqコマンドの結果を, DockerのUbuntuイメージに入っているawkコマンドを使って偶数だけ出力するようフィルタしたい」

とします.# seqコマンドの結果 $ seq 10 1 2 3 4 5 6 7 8 9 10その場合は, パイプと

docker run -iコマンドを組み合わせれば実現できる, ということになります.$ seq 10 | docker run -i ubuntu:18.04 awk '$1 % 2 == 0' 2 4 6 8 10もうちょっと実用的な例をだします.

「作成したPythonスクリプトを, DockerのPythonイメージを使って実行したい」

ほとんどの場合は, volumeオプションでローカルPCのディレクトリを, Dockerコンテナに共有させて実行させますが,

場合によっては, リダイレクトが使えます.# Pythonスクリプトの中身 $ cat hoge.py print("hello") # PythonスクリプトをDockerコンテナのPythonにリダイレクトして実行 $ docker run -i python:3.7 python < hoge.py hellotty (-t, --tty) オプションは疑似端末

ここ, ちょっとちゃんと理解できてないところもあるのですが, ttyは「端末」のことです.

ここでいう端末は, たとえばプロンプトが表示されたbash/zsh などのインタラクティブシェルのことです.

REPLを備えたPythonなどもそうです.

コマンドを入力できて, 実行できて, 即座に実行結果が表示されるアレです.たとえば, Ubuntuのコンテナを起動すると同時に top コマンドを実行して監視してみたい

-tオプション指定がないと, 「TERM環境変数が設定されていない」というエラーがでて

起動すらできません.$ docker run --rm ubuntu:18.04 top TERM environment variable not set.docker run に

-tオプションを指定すると, topを起動できるようになります.

ちなみに,-tだけの指定で-iがないとキー入力が受け付けられなくなるため,

Qキー押下で終了できません.

(topコマンドはCtrl-C で割り込んで止められましたが,

起動するインタラクティブシェルによっては, それすらできないません.

別のターミナルでdockerコマンドを使ってコンテナを終了/停止する必要があります)類似のオプションは他のソフトウェアにもあったりします.

たとえば, sshで接続した先でコマンドを実行する場合,

ssh $xxx_host programのように実行コマンドを指定します.この実行コマンドがインタラクティブシェル/REPLである場合は (インタラクティブシェルとして使いたい場合は),

-tを指定する必要があります.

ssh -t $xxx_host pythonのように.まとめ (というほどではないけど)

-iオプションだけ指定することが有用なケースはそれなりにある-tオプションだけ指定する状況はちょっと思いつかない参考資料

- 投稿日:2020-02-28T12:21:42+09:00

docker コマンドだけで起動する proxy サーバ

proxy という npm パッケージを node コンテナで実行するだけでお手軽に proxy サーバが起動できる。

コマンド

$ docker run --rm -p 8888:3128 node npx proxy

- proxy コマンドはデフォルトで

3128ポートをListenするのでそれをホスト側の8888にポートマッピングしているブラウザの設定(Firefoxの場合)

- Manual Proxy setting でホスト名を

localhost、ポート番号を先のコマンドでポートマッピングしたportに設定参考

- 投稿日:2020-02-28T11:54:33+09:00

GitLab-CI + Cypressで自動テストを実行すると、レンダラーのクラッシュで異常終了

背景

以前の投稿でGitLab-CIとCypressを連携して、Webアプリケーションの自動テスト環境を構築した。

当初は何ら問題なく動いていたが、ある時から以下のエラーを吐いてパイプラインが

Failedになるようになってしまった。本投稿では、その対処方法を掲載する。

We detected that the Chromium Renderer process just crashed. This is the equivalent to seeing the 'sad face' when Chrome dies. This can happen for a number of different reasons: - You wrote an endless loop and you must fix your own code - There is a memory leak in Cypress (unlikely but possible) - You are running Docker (there is an easy fix for this: see link below) - You are running lots of tests on a memory intense application - You are running in a memory starved VM environment - There are problems with your GPU / GPU drivers - There are browser bugs in Chromium You can learn more including how to fix Docker here: https://on.cypress.io/renderer-process-crashed環境

- CentOS 7.5.1804

- GitLab CE 11.11.3

- gitlab-runner v12.6.0

- Cypress v3.7.0

調査

ヒントは、エラーメッセージ末尾に書かれていた。

You can learn more including how to fix Docker here:

https://on.cypress.io/renderer-process-crashedリンクを辿ると最終的にGitHubのIssueスレッドにたどり着く。

スレッドを読むと、この投稿に解決策が記載されていた。対処

1. gitlab-runnerのconfigを修正

修正すべきファイルは、gitlab-runnerのコンテナの中であれば

/etc/gitlab-runner/config.toml、コンテナ作成時にvolumesを指定してホストOS側のパスをマウントしている場合は、そのファイルを直接編集すると良い。config.toml[[runners]] ... executor = "docker" ... [runners.docker] ... volumes = ["/dev/shm:/dev/shm", ...other volumes...] ... [runners.cache]2. gitlab-runnerを再起動

# ホストOSから実行する場合 docker exec gitlab-runner-docker gitlab-runner restart # コンテナにログイン後に実行する場合 gitlab-runner restart

- 投稿日:2020-02-28T10:58:42+09:00

Quorumのサンプル動作

はじめに

「Ethereumは使ったことがあるけど、Ethereum Enterprise版を使ったことがない。」

「Quorumを聞いたことはあるが、使ったことがない。」という人向けです。

Ethereum Enterprise版の Quorum の動かし方を学びます。

Quorumとは

Quorum は、トランザクション/コントラクトのプライバシーと新しいコンセンサスメカニズムを備えたイーサリアムベースの分散台帳プロトコルです。

クォーラムは

go-ethereumのフォークであり、go-ethereumのリリースに合わせて更新されます。リンクまとめ

- ホームページ

- Git

- ドキュメント

- サンプル

主要な機能

- Privacy: Quorumは、パブリック/プライベート状態の分離を通じてプライベートトランザクションとプライベートコントラクトをサポートし、P2P暗号化メッセージ交換(ConstellationおよびTesseraを参照)を使用して、プライベートデータをネットワーク参加者に直接転送します

- Alternative Consensus Mechanisms: 許可されたネットワークでPOW / POSを使用する必要がないため、Quorumは代わりに、コンソーシアムチェーンにより適した複数のコンセンサスメカニズムを提供します。

- Raft-based Consensus: ブロック時間、トランザクションの最終性、およびオンデマンドブロック作成を高速化するためのコンセンサスモデル

- Istanbul BFT: AMISによるトランザクションの最終性を備えたPBFTにヒントを得たコンセンサスアルゴリズム。

- Peer Permissioning: スマートコントラクトを使用したノード/ピアの許可。既知の関係者のみがネットワークに参加できるようにします。

- Higher Performance: Quorumは、公開gethよりも大幅に高いパフォーマンスを提供します

ダウンロード

Quorum のサンプルを Git から取得します。

$ git clone https://github.com/jpmorganchase/quorum-examples $ cd quorum-examples動作確認

Dockerで立ち上げます。

$ docker-compose up -dDockerが立ち上がったか確認してみましょう。

$ docker ps CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 86c1fe5b22fc quorumengineering/quorum:2.4.0 "/bin/sh -c 'UDS_WAI…" 9 seconds ago Up 5 seconds (health: starting) 8546/tcp, 21000/tcp, 30303/tcp, 50400/tcp, 30303/udp, 0.0.0.0:22002->8545/tcp quorum-examples_node3_1 7a495a567f8d quorumengineering/quorum:2.4.0 "/bin/sh -c 'UDS_WAI…" 9 seconds ago Up 5 seconds (health: starting) 8546/tcp, 21000/tcp, 30303/tcp, 50400/tcp, 30303/udp, 0.0.0.0:22000->8545/tcp quorum-examples_node1_1 1d7079247b29 quorumengineering/quorum:2.4.0 "/bin/sh -c 'UDS_WAI…" 9 seconds ago Up 5 seconds (health: starting) 8546/tcp, 21000/tcp, 30303/tcp, 50400/tcp, 30303/udp, 0.0.0.0:22005->8545/tcp quorum-examples_node6_1 be5a3f8e5a0e quorumengineering/quorum:2.4.0 "/bin/sh -c 'UDS_WAI…" 9 seconds ago Up 5 seconds (health: starting) 8546/tcp, 21000/tcp, 30303/tcp, 50400/tcp, 30303/udp, 0.0.0.0:22003->8545/tcp quorum-examples_node4_1 7deb7a02d97a quorumengineering/quorum:2.4.0 "/bin/sh -c 'UDS_WAI…" 10 seconds ago Up 6 seconds (health: starting) 8546/tcp, 21000/tcp, 30303/tcp, 50400/tcp, 30303/udp, 0.0.0.0:22001->8545/tcp quorum-examples_node2_1 d483ea254c41 quorumengineering/quorum:2.4.0 "/bin/sh -c 'UDS_WAI…" 10 seconds ago Up 5 seconds (health: starting) 8546/tcp, 21000/tcp, 30303/tcp, 50400/tcp, 30303/udp, 0.0.0.0:22006->8545/tcp quorum-examples_node7_1 cf8c85e59cd6 quorumengineering/quorum:2.4.0 "/bin/sh -c 'UDS_WAI…" 10 seconds ago Up 6 seconds (health: starting) 8546/tcp, 21000/tcp, 30303/tcp, 50400/tcp, 30303/udp, 0.0.0.0:22004->8545/tcp quorum-examples_node5_1 4c22e504b943 quorumengineering/cakeshop:0.11.0-RC2 "/bin/sh -c 'DDIR=/q…" 12 seconds ago Up 7 seconds (health: starting) 8080/tcp, 8102/tcp, 0.0.0.0:8999->8999/tcp quorum-examples_cakeshop_1 de2c803c03c1 quorumengineering/tessera:0.10.3 "/bin/sh -c 'if [ \"$…" 12 seconds ago Up 9 seconds (health: starting) 9000/tcp, 0.0.0.0:9085->9080/tcp quorum-examples_txmanager5_1 f39fb0103c4f quorumengineering/tessera:0.10.3 "/bin/sh -c 'if [ \"$…" 12 seconds ago Up 8 seconds (health: starting) 9000/tcp, 0.0.0.0:9081->9080/tcp quorum-examples_txmanager1_1 aa4f16bf26bc quorumengineering/tessera:0.10.3 "/bin/sh -c 'if [ \"$…" 12 seconds ago Up 8 seconds (health: starting) 9000/tcp, 0.0.0.0:9083->9080/tcp quorum-examples_txmanager3_1 2b964d12ba0c quorumengineering/tessera:0.10.3 "/bin/sh -c 'if [ \"$…" 12 seconds ago Up 8 seconds (health: starting) 9000/tcp, 0.0.0.0:9084->9080/tcp quorum-examples_txmanager4_1 29276e52b8c4 quorumengineering/tessera:0.10.3 "/bin/sh -c 'if [ \"$…" 12 seconds ago Up 8 seconds (health: starting) 9000/tcp, 0.0.0.0:9086->9080/tcp quorum-examples_txmanager6_1 04c87773a143 quorumengineering/tessera:0.10.3 "/bin/sh -c 'if [ \"$…" 12 seconds ago Up 9 seconds (health: starting) 9000/tcp, 0.0.0.0:9082->9080/tcp quorum-examples_txmanager2_1 a94c254ca903 quorumengineering/tessera:0.10.3 "/bin/sh -c 'if [ \"$…" 12 seconds ago Up 9 seconds (health: starting) 9000/tcp, 0.0.0.0:9087->9080/tcp quorum-examples_txmanager7_1Nodeへのアクセス

次のコマンドは、

docker-compose up -dで立ち上げてから、数分経過しないとエラーになります。。。

また、エラーにならなくても、consoleが出るまでに数分かかります。$ docker exec -it quorum-examples_node1_1 geth attach /qdata/dd/geth.ipc Welcome to the Geth JavaScript console! instance: Geth/node1-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13 coinbase: 0xd8dba507e85f116b1f7e231ca8525fc9008a6966 at block: 6 (Thu, 27 Feb 2020 10:06:16 UTC) datadir: /qdata/dd modules: admin:1.0 debug:1.0 eth:1.0 istanbul:1.0 miner:1.0 net:1.0 personal:1.0 rpc:1.0 txpool:1.0 web3:1.0エラー時は以下、エラーの時はすぐに出力されます。

$ docker exec -it quorum-examples_node1_1 geth attach /qdata/dd/geth.ipc panic: MustNew: Failed to connect to Constellation (/qdata/tm/tm.ipc): lstat /qdata/tm/tm.ipc: no such file or directory goroutine 1 [running]: github.com/ethereum/go-ethereum/private/constellation.MustNew(0xc00003800f, 0x10, 0xc00003800f) /go-ethereum/build/_workspace/src/github.com/ethereum/go-ethereum/private/constellation/constellation.go:108 +0x1de github.com/ethereum/go-ethereum/private.FromEnvironmentOrNil(0x11bbb1d, 0xe, 0xc0001ef5a0, 0xc0001ef580) /go-ethereum/build/_workspace/src/github.com/ethereum/go-ethereum/private/private.go:20 +0x64コントラクトのデプロイ

コンソールに入って、下記のコマンドを実行し、コントラクトをチェーン上へデプロイします。(これもコンソールが立ち上がってから通るまでに、数分かかりました。。。)

> loadScript('/examples/private-contract.js') Contract transaction send: TransactionHash: 0xcca72b49194d7d1a90746ac0cc9f50c1ac870b8c914d2079c044e7b7065abd74 waiting to be mined... true > Contract mined! Address: 0x1932c48b2bf8102ba33b4a6b545c32236e342f34 [object Object]生成したトランザクションの中身を確認してみましょう。

> eth.getTransaction("0xcca72b49194d7d1a90746ac0cc9f50c1ac870b8c914d2079c044e7b7065abd74") { blockHash: "0x1d678eac0ebf0a7c3c2b2f222f93190d8f27a3951129c397857ddf2a190f51df", blockNumber: 19, from: "0xed9d02e382b34818e88b88a309c7fe71e65f419d", gas: 4700000, gasPrice: 0, hash: "0xcca72b49194d7d1a90746ac0cc9f50c1ac870b8c914d2079c044e7b7065abd74", input: "0x2fb0476e23e90ac27f7a202550f6497e967b80a5776cbf9475a14f562a61b213ec7d914302c3a948d8f459c160adbfaf2a2c9a2e4f6eb5b750746de4f3df7c3e", nonce: 0, r: "0xbe181b4eaad9559338f49cae1a8add46938518f7f582bd26e19ed06dab73b8e1", s: "0x5fcd1eb6afa30c1277b2cf7fb8a0b11fd0a85796637f2992955ec88da8eb0046", to: null, transactionIndex: 0, v: "0x25", value: 0 }コントラクトを生成できたので、Node1からコントラクトへアクセスしてみましょう。

> var address = "0x1932c48b2bf8102ba33b4a6b545c32236e342f34" undefined > var abi = [{"constant":true,"inputs":[],"name":"storedData","outputs":[{"name":"","type":"uint256"}],"payable":false,"type":"function"},{"constant":false,"inputs":[{"name":"x","type":"uint256"}],"name":"set","outputs":[],"payable":false,"type":"function"},{"constant":true,"inputs":[],"name":"get","outputs":[{"name":"retVal","type":"uint256"}],"payable":false,"type":"function"},{"inputs":[{"name":"initVal","type":"uint256"}],"type":"constructor"}]; undefined > var private = eth.contract(abi).at(address) undefined > private.get() 4242が取得できていることがわかります。

他の Node からのコントラクトへアクセス

同様に、node4 と node7 から取得できるかを確認してみます。

Node4

$ docker exec -it quorum-examples_node4_1 geth attach /qdata/dd/geth.ipc Welcome to the Geth JavaScript console! instance: Geth/node4-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13 coinbase: 0xf512a992f3fb749857d758ffda1330e590fa915e at block: 320 (Thu, 27 Feb 2020 10:27:12 UTC) datadir: /qdata/dd modules: admin:1.0 debug:1.0 eth:1.0 istanbul:1.0 miner:1.0 net:1.0 personal:1.0 rpc:1.0 txpool:1.0 web3:1.0 > private.get() ReferenceError: 'private' is not defined at <anonymous>:1:1 > var address = "0x1932c48b2bf8102ba33b4a6b545c32236e342f34" undefined > var abi = [{"constant":true,"inputs":[],"name":"storedData","outputs":[{"name":"","type":"uint256"}],"payable":false,"type":"function"},{"constant":false,"inputs":[{"name":"x","type":"uint256"}],"name":"set","outputs":[],"payable":false,"type":"function"},{"constant":true,"inputs":[],"name":"get","outputs":[{"name":"retVal","type":"uint256"}],"payable":false,"type":"function"},{"inputs":[{"name":"initVal","type":"uint256"}],"type":"constructor"}]; undefined > var private = eth.contract(abi).at(address) undefined > private.get() 0Node7

$ docker exec -it quorum-examples_node7_1 geth attach /qdata/dd/geth.ipc Welcome to the Geth JavaScript console! instance: Geth/node7-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13 coinbase: 0xb131288f355bc27090e542ae0be213c20350b767 at block: 407 (Thu, 27 Feb 2020 10:29:38 UTC) datadir: /qdata/dd modules: admin:1.0 debug:1.0 eth:1.0 istanbul:1.0 miner:1.0 net:1.0 personal:1.0 rpc:1.0 txpool:1.0 web3:1.0 > var address = "0x1932c48b2bf8102ba33b4a6b545c32236e342f34" undefined > var abi = [{"constant":true,"inputs":[],"name":"storedData","outputs":[{"name":"","type":"uint256"}],"payable":false,"type":"function"},{"constant":false,"inputs":[{"name":"x","type":"uint256"}],"name":"set","outputs":[],"payable":false,"type":"function"},{"constant":true,"inputs":[],"name":"get","outputs":[{"name":"retVal","type":"uint256"}],"payable":false,"type":"function"},{"inputs":[{"name":"initVal","type":"uint256"}],"type":"constructor"}]; undefined > var private = eth.contract(abi).at(address) undefined > private.get() 42node4からは0、node7からは42が取得されています。

動作のまとめ

したがって、ノード1と7がプライベートコントラクトの状態を読み取ることができ、その初期値は42です。

private-contract.jsを見ると、42の値がコントラクトの作成時に設定された値であることがわかります。

ノード4は状態を読み取ることができません。コントラクトの値の書き換え

node1 のコンソールで下記のように設定すると、値が書き換わります。

> private.set(4,{from:eth.accounts[0],privateFor:["ROAZBWtSacxXQrOe3FGAqJDyJjFePR5ce4TSIzmJ0Bc="]}); "0x189a5755c0a1104445cb83a4689221494794832ab6e6cefa5ee6a02696fc38ac" > private.get() 4これを、Node4 と Node7 から確認したのが下記です。

Node4

> private.get() 0Node7

> private.get() 4Node1, Node7 からアクセスできて、Node4からはアクセスできていないことがわかります。

Permissions

Node Permissioningは、事前に定義された一連のノード(remotekey / enodesで識別される)のみが許可されたネットワークに接続できるようにするQuorumの機能です。

geth attach path/to/geth.ipcで個々のノードに接続し、接続されたノードを確認するためにadmin.peersを使用します。> admin.peers [{ caps: ["istanbul/64"], enode: "enode://239c1f044a2b03b6c4713109af036b775c5418fe4ca63b04b1ce00124af00ddab7cc088fc46020cdc783b6207efe624551be4c06a994993d8d70f684688fb7cf@172.16.239.17:40062", id: "3cb4aaea0f49f73c9de4a34db131288f355bc27090e542ae0be213c20350b767", name: "Geth/node7-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13", network: { inbound: true, localAddress: "172.16.239.11:21000", remoteAddress: "172.16.239.17:40062", static: false, trusted: false }, protocols: { istanbul: { difficulty: 1169, head: "0x765088e2cea778a865703c5a057398ce6d4d5d62de8785e8ae898547da0ac4c8", version: 64 } } }, { caps: ["istanbul/64"], enode: "enode://0ba6b9f606a43a95edc6247cdb1c1e105145817be7bcafd6b2c0ba15d58145f0dc1a194f70ba73cd6f4cdd6864edc7687f311254c7555cc32e4d45aeb1b80416@172.16.239.12:54236", id: "995dbe18829f1affb75402e66571d97f340c8495b661a823f2c2145ca47d63c2", name: "Geth/node2-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13", network: { inbound: true, localAddress: "172.16.239.11:21000", remoteAddress: "172.16.239.12:54236", static: false, trusted: false }, protocols: { istanbul: { difficulty: 1167, head: "0xd8ff13d791864d599dbed913f416af92413cc2422ebe9f3e14bb575c795c5728", version: 64 } } }, { caps: ["istanbul/64"], enode: "enode://eacaa74c4b0e7a9e12d2fe5fee6595eda841d6d992c35dbbcc50fcee4aa86dfbbdeff7dc7e72c2305d5a62257f82737a8cffc80474c15c611c037f52db1a3a7b@172.16.239.16:21000?discport=0&raftport=50400", id: "ab62dd7df5863a5f3bb61f458157d4437104e3b8df4451a85f7b2438ef6699ff", name: "Geth/node6-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13", network: { inbound: false, localAddress: "172.16.239.11:52212", remoteAddress: "172.16.239.16:21000", static: true, trusted: false }, protocols: { istanbul: { difficulty: 1169, head: "0x765088e2cea778a865703c5a057398ce6d4d5d62de8785e8ae898547da0ac4c8", version: 64 } } }, { caps: ["istanbul/64"], enode: "enode://579f786d4e2830bbcc02815a27e8a9bacccc9605df4dc6f20bcc1a6eb391e7225fff7cb83e5b4ecd1f3a94d8b733803f2f66b7e871961e7b029e22c155c3a778@172.16.239.13:21000?discport=0&raftport=50400", id: "c39143f98d04e97bd9e31ac1e36cbeb565b061217930767886474e3cde903ac5", name: "Geth/node3-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13", network: { inbound: false, localAddress: "172.16.239.11:43438", remoteAddress: "172.16.239.13:21000", static: true, trusted: false }, protocols: { istanbul: { difficulty: 1167, head: "0xd8ff13d791864d599dbed913f416af92413cc2422ebe9f3e14bb575c795c5728", version: 64 } } }, { caps: ["istanbul/64"], enode: "enode://3d9ca5956b38557aba991e31cf510d4df641dce9cc26bfeb7de082f0c07abb6ede3a58410c8f249dabeecee4ad3979929ac4c7c496ad20b8cfdd061b7401b4f5@172.16.239.14:21000?discport=0&raftport=50400", id: "c75f7dcb9fd6063f0ada0998f512a992f3fb749857d758ffda1330e590fa915e", name: "Geth/node4-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13", network: { inbound: false, localAddress: "172.16.239.11:47280", remoteAddress: "172.16.239.14:21000", static: true, trusted: false }, protocols: { istanbul: { difficulty: 1166, head: "0xdb21189404e3e5d8c111ca1ced00f149033bedcd9c23e844c12ac149c47b9b49", version: 64 } } }, { caps: ["istanbul/64"], enode: "enode://3701f007bfa4cb26512d7df18e6bbd202e8484a6e11d387af6e482b525fa25542d46ff9c99db87bd419b980c24a086117a397f6d8f88e74351b41693880ea0cb@172.16.239.15:59474", id: "f06c06f1e958cb2edf90d8bfb912de287f9b047b4228436e94b5b78e3ee16171", name: "Geth/node5-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13", network: { inbound: true, localAddress: "172.16.239.11:21000", remoteAddress: "172.16.239.15:59474", static: false, trusted: false }, protocols: { istanbul: { difficulty: 1169, head: "0x765088e2cea778a865703c5a057398ce6d4d5d62de8785e8ae898547da0ac4c8", version: 64 } } }]Permissions の構成

gethノードのリモートキーに基づいて許可が付与されます。リモートキー

permissioned-nodes.jsonはで指定され、個々のノードの<datadir>の下に配置されます。permissioned-nodes.json[ "enode://ac6b1096ca56b9f6d004b779ae3728bf83f8e22453404cc3cef16a3d9b96608bc67c4b30db88e0a5a6c6390213f7acbe1153ff6d23ce57380104288ae19373ef@127.0.0.1:21000?discport=0&raftport=50401", "enode://0ba6b9f606a43a95edc6247cdb1c1e105145817be7bcafd6b2c0ba15d58145f0dc1a194f70ba73cd6f4cdd6864edc7687f311254c7555cc32e4d45aeb1b80416@127.0.0.1:21001?discport=0&raftport=50402", "enode://579f786d4e2830bbcc02815a27e8a9bacccc9605df4dc6f20bcc1a6eb391e7225fff7cb83e5b4ecd1f3a94d8b733803f2f66b7e871961e7b029e22c155c3a778@127.0.0.1:21002?discport=0&raftport=50403", "enode://3d9ca5956b38557aba991e31cf510d4df641dce9cc26bfeb7de082f0c07abb6ede3a58410c8f249dabeecee4ad3979929ac4c7c496ad20b8cfdd061b7401b4f5@127.0.0.1:21003?discport=0&raftport=50404", "enode://3701f007bfa4cb26512d7df18e6bbd202e8484a6e11d387af6e482b525fa25542d46ff9c99db87bd419b980c24a086117a397f6d8f88e74351b41693880ea0cb@127.0.0.1:21004?discport=0&raftport=50405", "enode://eacaa74c4b0e7a9e12d2fe5fee6595eda841d6d992c35dbbcc50fcee4aa86dfbbdeff7dc7e72c2305d5a62257f82737a8cffc80474c15c611c037f52db1a3a7b@127.0.0.1:21005?discport=0&raftport=50406", "enode://239c1f044a2b03b6c4713109af036b775c5418fe4ca63b04b1ce00124af00ddab7cc088fc46020cdc783b6207efe624551be4c06a994993d8d70f684688fb7cf@127.0.0.1:21006?discport=0&raftport=50407" ]Permissions の有効化/無効化

個々のノードは、gethを立てる際に

-permissionedコマンドラインフラグを渡すことで許可を有効または無効にできます。

有効になっている場合、<datadir>/permissioned-nodes.jsonのノードのみが接続できます。

さらに、これらは、このノードがアウトバウンド接続を行うことができる唯一のノードです終わりに

サンプルだけでは少々物足りないですね。

もっと調査します。Nodeについて調査しました。

https://qiita.com/ryu3/items/2552a0a48e3e5164aa26

- 投稿日:2020-02-28T10:58:42+09:00

Quorum

はじめに

「Ethereumは使ったことがあるけど、Ethereum Enterprise版を使ったことがない。」

「Quorumを聞いたことはあるが、使ったことがない。」という人向けです。

Ethereum Enterprise版の Quorum の動かし方を学びます。

Quorumとは

Quorum は、トランザクション/コントラクトのプライバシーと新しいコンセンサスメカニズムを備えたイーサリアムベースの分散台帳プロトコルです。

クォーラムは

go-ethereumのフォークであり、go-ethereumのリリースに合わせて更新されます。リンクまとめ

- ホームページ

- Git

- ドキュメント

- サンプル

主要な機能

- Privacy: Quorumは、パブリック/プライベート状態の分離を通じてプライベートトランザクションとプライベートコントラクトをサポートし、P2P暗号化メッセージ交換(ConstellationおよびTesseraを参照)を使用して、プライベートデータをネットワーク参加者に直接転送します

- Alternative Consensus Mechanisms: 許可されたネットワークでPOW / POSを使用する必要がないため、Quorumは代わりに、コンソーシアムチェーンにより適した複数のコンセンサスメカニズムを提供します。

- Raft-based Consensus: ブロック時間、トランザクションの最終性、およびオンデマンドブロック作成を高速化するためのコンセンサスモデル

- Istanbul BFT: AMISによるトランザクションの最終性を備えたPBFTにヒントを得たコンセンサスアルゴリズム。

- Peer Permissioning: スマートコントラクトを使用したノード/ピアの許可。既知の関係者のみがネットワークに参加できるようにします。

- Higher Performance: Quorumは、公開gethよりも大幅に高いパフォーマンスを提供します

ダウンロード

Quorum のサンプルを Git から取得します。

$ git clone https://github.com/jpmorganchase/quorum-examples $ cd quorum-examples動作確認

Dockerで立ち上げます。

$ docker-compose up -dDockerが立ち上がったか確認してみましょう。

$ docker ps CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 86c1fe5b22fc quorumengineering/quorum:2.4.0 "/bin/sh -c 'UDS_WAI…" 9 seconds ago Up 5 seconds (health: starting) 8546/tcp, 21000/tcp, 30303/tcp, 50400/tcp, 30303/udp, 0.0.0.0:22002->8545/tcp quorum-examples_node3_1 7a495a567f8d quorumengineering/quorum:2.4.0 "/bin/sh -c 'UDS_WAI…" 9 seconds ago Up 5 seconds (health: starting) 8546/tcp, 21000/tcp, 30303/tcp, 50400/tcp, 30303/udp, 0.0.0.0:22000->8545/tcp quorum-examples_node1_1 1d7079247b29 quorumengineering/quorum:2.4.0 "/bin/sh -c 'UDS_WAI…" 9 seconds ago Up 5 seconds (health: starting) 8546/tcp, 21000/tcp, 30303/tcp, 50400/tcp, 30303/udp, 0.0.0.0:22005->8545/tcp quorum-examples_node6_1 be5a3f8e5a0e quorumengineering/quorum:2.4.0 "/bin/sh -c 'UDS_WAI…" 9 seconds ago Up 5 seconds (health: starting) 8546/tcp, 21000/tcp, 30303/tcp, 50400/tcp, 30303/udp, 0.0.0.0:22003->8545/tcp quorum-examples_node4_1 7deb7a02d97a quorumengineering/quorum:2.4.0 "/bin/sh -c 'UDS_WAI…" 10 seconds ago Up 6 seconds (health: starting) 8546/tcp, 21000/tcp, 30303/tcp, 50400/tcp, 30303/udp, 0.0.0.0:22001->8545/tcp quorum-examples_node2_1 d483ea254c41 quorumengineering/quorum:2.4.0 "/bin/sh -c 'UDS_WAI…" 10 seconds ago Up 5 seconds (health: starting) 8546/tcp, 21000/tcp, 30303/tcp, 50400/tcp, 30303/udp, 0.0.0.0:22006->8545/tcp quorum-examples_node7_1 cf8c85e59cd6 quorumengineering/quorum:2.4.0 "/bin/sh -c 'UDS_WAI…" 10 seconds ago Up 6 seconds (health: starting) 8546/tcp, 21000/tcp, 30303/tcp, 50400/tcp, 30303/udp, 0.0.0.0:22004->8545/tcp quorum-examples_node5_1 4c22e504b943 quorumengineering/cakeshop:0.11.0-RC2 "/bin/sh -c 'DDIR=/q…" 12 seconds ago Up 7 seconds (health: starting) 8080/tcp, 8102/tcp, 0.0.0.0:8999->8999/tcp quorum-examples_cakeshop_1 de2c803c03c1 quorumengineering/tessera:0.10.3 "/bin/sh -c 'if [ \"$…" 12 seconds ago Up 9 seconds (health: starting) 9000/tcp, 0.0.0.0:9085->9080/tcp quorum-examples_txmanager5_1 f39fb0103c4f quorumengineering/tessera:0.10.3 "/bin/sh -c 'if [ \"$…" 12 seconds ago Up 8 seconds (health: starting) 9000/tcp, 0.0.0.0:9081->9080/tcp quorum-examples_txmanager1_1 aa4f16bf26bc quorumengineering/tessera:0.10.3 "/bin/sh -c 'if [ \"$…" 12 seconds ago Up 8 seconds (health: starting) 9000/tcp, 0.0.0.0:9083->9080/tcp quorum-examples_txmanager3_1 2b964d12ba0c quorumengineering/tessera:0.10.3 "/bin/sh -c 'if [ \"$…" 12 seconds ago Up 8 seconds (health: starting) 9000/tcp, 0.0.0.0:9084->9080/tcp quorum-examples_txmanager4_1 29276e52b8c4 quorumengineering/tessera:0.10.3 "/bin/sh -c 'if [ \"$…" 12 seconds ago Up 8 seconds (health: starting) 9000/tcp, 0.0.0.0:9086->9080/tcp quorum-examples_txmanager6_1 04c87773a143 quorumengineering/tessera:0.10.3 "/bin/sh -c 'if [ \"$…" 12 seconds ago Up 9 seconds (health: starting) 9000/tcp, 0.0.0.0:9082->9080/tcp quorum-examples_txmanager2_1 a94c254ca903 quorumengineering/tessera:0.10.3 "/bin/sh -c 'if [ \"$…" 12 seconds ago Up 9 seconds (health: starting) 9000/tcp, 0.0.0.0:9087->9080/tcp quorum-examples_txmanager7_1Nodeへのアクセス

次のコマンドは、

docker-compose up -dで立ち上げてから、数分経過しないとエラーになります。。。

また、エラーにならなくても、consoleが出るまでに数分かかります。$ docker exec -it quorum-examples_node1_1 geth attach /qdata/dd/geth.ipc Welcome to the Geth JavaScript console! instance: Geth/node1-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13 coinbase: 0xd8dba507e85f116b1f7e231ca8525fc9008a6966 at block: 6 (Thu, 27 Feb 2020 10:06:16 UTC) datadir: /qdata/dd modules: admin:1.0 debug:1.0 eth:1.0 istanbul:1.0 miner:1.0 net:1.0 personal:1.0 rpc:1.0 txpool:1.0 web3:1.0エラー時は以下、エラーの時はすぐに出力されます。

$ docker exec -it quorum-examples_node1_1 geth attach /qdata/dd/geth.ipc panic: MustNew: Failed to connect to Constellation (/qdata/tm/tm.ipc): lstat /qdata/tm/tm.ipc: no such file or directory goroutine 1 [running]: github.com/ethereum/go-ethereum/private/constellation.MustNew(0xc00003800f, 0x10, 0xc00003800f) /go-ethereum/build/_workspace/src/github.com/ethereum/go-ethereum/private/constellation/constellation.go:108 +0x1de github.com/ethereum/go-ethereum/private.FromEnvironmentOrNil(0x11bbb1d, 0xe, 0xc0001ef5a0, 0xc0001ef580) /go-ethereum/build/_workspace/src/github.com/ethereum/go-ethereum/private/private.go:20 +0x64コントラクトのデプロイ

コンソールに入って、下記のコマンドを実行し、コントラクトをチェーン上へデプロイします。(これもコンソールが立ち上がってから通るまでに、数分かかりました。。。)

> loadScript('/examples/private-contract.js') Contract transaction send: TransactionHash: 0xcca72b49194d7d1a90746ac0cc9f50c1ac870b8c914d2079c044e7b7065abd74 waiting to be mined... true > Contract mined! Address: 0x1932c48b2bf8102ba33b4a6b545c32236e342f34 [object Object]生成したトランザクションの中身を確認してみましょう。

> eth.getTransaction("0xcca72b49194d7d1a90746ac0cc9f50c1ac870b8c914d2079c044e7b7065abd74") { blockHash: "0x1d678eac0ebf0a7c3c2b2f222f93190d8f27a3951129c397857ddf2a190f51df", blockNumber: 19, from: "0xed9d02e382b34818e88b88a309c7fe71e65f419d", gas: 4700000, gasPrice: 0, hash: "0xcca72b49194d7d1a90746ac0cc9f50c1ac870b8c914d2079c044e7b7065abd74", input: "0x2fb0476e23e90ac27f7a202550f6497e967b80a5776cbf9475a14f562a61b213ec7d914302c3a948d8f459c160adbfaf2a2c9a2e4f6eb5b750746de4f3df7c3e", nonce: 0, r: "0xbe181b4eaad9559338f49cae1a8add46938518f7f582bd26e19ed06dab73b8e1", s: "0x5fcd1eb6afa30c1277b2cf7fb8a0b11fd0a85796637f2992955ec88da8eb0046", to: null, transactionIndex: 0, v: "0x25", value: 0 }コントラクトを生成できたので、Node1からコントラクトへアクセスしてみましょう。

> var address = "0x1932c48b2bf8102ba33b4a6b545c32236e342f34" undefined > var abi = [{"constant":true,"inputs":[],"name":"storedData","outputs":[{"name":"","type":"uint256"}],"payable":false,"type":"function"},{"constant":false,"inputs":[{"name":"x","type":"uint256"}],"name":"set","outputs":[],"payable":false,"type":"function"},{"constant":true,"inputs":[],"name":"get","outputs":[{"name":"retVal","type":"uint256"}],"payable":false,"type":"function"},{"inputs":[{"name":"initVal","type":"uint256"}],"type":"constructor"}]; undefined > var private = eth.contract(abi).at(address) undefined > private.get() 4242が取得できていることがわかります。

他の Node からのコントラクトへアクセス

同様に、node4 と node7 から取得できるかを確認してみます。

Node4

$ docker exec -it quorum-examples_node4_1 geth attach /qdata/dd/geth.ipc Welcome to the Geth JavaScript console! instance: Geth/node4-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13 coinbase: 0xf512a992f3fb749857d758ffda1330e590fa915e at block: 320 (Thu, 27 Feb 2020 10:27:12 UTC) datadir: /qdata/dd modules: admin:1.0 debug:1.0 eth:1.0 istanbul:1.0 miner:1.0 net:1.0 personal:1.0 rpc:1.0 txpool:1.0 web3:1.0 > private.get() ReferenceError: 'private' is not defined at <anonymous>:1:1 > var address = "0x1932c48b2bf8102ba33b4a6b545c32236e342f34" undefined > var abi = [{"constant":true,"inputs":[],"name":"storedData","outputs":[{"name":"","type":"uint256"}],"payable":false,"type":"function"},{"constant":false,"inputs":[{"name":"x","type":"uint256"}],"name":"set","outputs":[],"payable":false,"type":"function"},{"constant":true,"inputs":[],"name":"get","outputs":[{"name":"retVal","type":"uint256"}],"payable":false,"type":"function"},{"inputs":[{"name":"initVal","type":"uint256"}],"type":"constructor"}]; undefined > var private = eth.contract(abi).at(address) undefined > private.get() 0Node7

$ docker exec -it quorum-examples_node7_1 geth attach /qdata/dd/geth.ipc Welcome to the Geth JavaScript console! instance: Geth/node7-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13 coinbase: 0xb131288f355bc27090e542ae0be213c20350b767 at block: 407 (Thu, 27 Feb 2020 10:29:38 UTC) datadir: /qdata/dd modules: admin:1.0 debug:1.0 eth:1.0 istanbul:1.0 miner:1.0 net:1.0 personal:1.0 rpc:1.0 txpool:1.0 web3:1.0 > var address = "0x1932c48b2bf8102ba33b4a6b545c32236e342f34" undefined > var abi = [{"constant":true,"inputs":[],"name":"storedData","outputs":[{"name":"","type":"uint256"}],"payable":false,"type":"function"},{"constant":false,"inputs":[{"name":"x","type":"uint256"}],"name":"set","outputs":[],"payable":false,"type":"function"},{"constant":true,"inputs":[],"name":"get","outputs":[{"name":"retVal","type":"uint256"}],"payable":false,"type":"function"},{"inputs":[{"name":"initVal","type":"uint256"}],"type":"constructor"}]; undefined > var private = eth.contract(abi).at(address) undefined > private.get() 42node4からは0、node7からは42が取得されています。

動作のまとめ

したがって、ノード1と7がプライベートコントラクトの状態を読み取ることができ、その初期値は42です。

private-contract.jsを見ると、42の値がコントラクトの作成時に設定された値であることがわかります。

ノード4は状態を読み取ることができません。コントラクトの値の書き換え

node1 のコンソールで下記のように設定すると、値が書き換わります。

> private.set(4,{from:eth.accounts[0],privateFor:["ROAZBWtSacxXQrOe3FGAqJDyJjFePR5ce4TSIzmJ0Bc="]}); "0x189a5755c0a1104445cb83a4689221494794832ab6e6cefa5ee6a02696fc38ac" > private.get() 4これを、Node4 と Node7 から確認したのが下記です。

Node4

> private.get() 0Node7

> private.get() 4Node1, Node7 からアクセスできて、Node4からはアクセスできていないことがわかります。

Permissions

Node Permissioningは、事前に定義された一連のノード(remotekey / enodesで識別される)のみが許可されたネットワークに接続できるようにするQuorumの機能です。

geth attach path/to/geth.ipcで個々のノードに接続し、接続されたノードを確認するためにadmin.peersを使用します。> admin.peers [{ caps: ["istanbul/64"], enode: "enode://239c1f044a2b03b6c4713109af036b775c5418fe4ca63b04b1ce00124af00ddab7cc088fc46020cdc783b6207efe624551be4c06a994993d8d70f684688fb7cf@172.16.239.17:40062", id: "3cb4aaea0f49f73c9de4a34db131288f355bc27090e542ae0be213c20350b767", name: "Geth/node7-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13", network: { inbound: true, localAddress: "172.16.239.11:21000", remoteAddress: "172.16.239.17:40062", static: false, trusted: false }, protocols: { istanbul: { difficulty: 1169, head: "0x765088e2cea778a865703c5a057398ce6d4d5d62de8785e8ae898547da0ac4c8", version: 64 } } }, { caps: ["istanbul/64"], enode: "enode://0ba6b9f606a43a95edc6247cdb1c1e105145817be7bcafd6b2c0ba15d58145f0dc1a194f70ba73cd6f4cdd6864edc7687f311254c7555cc32e4d45aeb1b80416@172.16.239.12:54236", id: "995dbe18829f1affb75402e66571d97f340c8495b661a823f2c2145ca47d63c2", name: "Geth/node2-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13", network: { inbound: true, localAddress: "172.16.239.11:21000", remoteAddress: "172.16.239.12:54236", static: false, trusted: false }, protocols: { istanbul: { difficulty: 1167, head: "0xd8ff13d791864d599dbed913f416af92413cc2422ebe9f3e14bb575c795c5728", version: 64 } } }, { caps: ["istanbul/64"], enode: "enode://eacaa74c4b0e7a9e12d2fe5fee6595eda841d6d992c35dbbcc50fcee4aa86dfbbdeff7dc7e72c2305d5a62257f82737a8cffc80474c15c611c037f52db1a3a7b@172.16.239.16:21000?discport=0&raftport=50400", id: "ab62dd7df5863a5f3bb61f458157d4437104e3b8df4451a85f7b2438ef6699ff", name: "Geth/node6-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13", network: { inbound: false, localAddress: "172.16.239.11:52212", remoteAddress: "172.16.239.16:21000", static: true, trusted: false }, protocols: { istanbul: { difficulty: 1169, head: "0x765088e2cea778a865703c5a057398ce6d4d5d62de8785e8ae898547da0ac4c8", version: 64 } } }, { caps: ["istanbul/64"], enode: "enode://579f786d4e2830bbcc02815a27e8a9bacccc9605df4dc6f20bcc1a6eb391e7225fff7cb83e5b4ecd1f3a94d8b733803f2f66b7e871961e7b029e22c155c3a778@172.16.239.13:21000?discport=0&raftport=50400", id: "c39143f98d04e97bd9e31ac1e36cbeb565b061217930767886474e3cde903ac5", name: "Geth/node3-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13", network: { inbound: false, localAddress: "172.16.239.11:43438", remoteAddress: "172.16.239.13:21000", static: true, trusted: false }, protocols: { istanbul: { difficulty: 1167, head: "0xd8ff13d791864d599dbed913f416af92413cc2422ebe9f3e14bb575c795c5728", version: 64 } } }, { caps: ["istanbul/64"], enode: "enode://3d9ca5956b38557aba991e31cf510d4df641dce9cc26bfeb7de082f0c07abb6ede3a58410c8f249dabeecee4ad3979929ac4c7c496ad20b8cfdd061b7401b4f5@172.16.239.14:21000?discport=0&raftport=50400", id: "c75f7dcb9fd6063f0ada0998f512a992f3fb749857d758ffda1330e590fa915e", name: "Geth/node4-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13", network: { inbound: false, localAddress: "172.16.239.11:47280", remoteAddress: "172.16.239.14:21000", static: true, trusted: false }, protocols: { istanbul: { difficulty: 1166, head: "0xdb21189404e3e5d8c111ca1ced00f149033bedcd9c23e844c12ac149c47b9b49", version: 64 } } }, { caps: ["istanbul/64"], enode: "enode://3701f007bfa4cb26512d7df18e6bbd202e8484a6e11d387af6e482b525fa25542d46ff9c99db87bd419b980c24a086117a397f6d8f88e74351b41693880ea0cb@172.16.239.15:59474", id: "f06c06f1e958cb2edf90d8bfb912de287f9b047b4228436e94b5b78e3ee16171", name: "Geth/node5-istanbul/v1.8.18-stable-20c95e5d(quorum-v2.4.0)/linux-amd64/go1.11.13", network: { inbound: true, localAddress: "172.16.239.11:21000", remoteAddress: "172.16.239.15:59474", static: false, trusted: false }, protocols: { istanbul: { difficulty: 1169, head: "0x765088e2cea778a865703c5a057398ce6d4d5d62de8785e8ae898547da0ac4c8", version: 64 } } }]Permissions の構成

gethノードのリモートキーに基づいて許可が付与されます。リモートキー

permissioned-nodes.jsonはで指定され、個々のノードの<datadir>の下に配置されます。permissioned-nodes.json[ "enode://ac6b1096ca56b9f6d004b779ae3728bf83f8e22453404cc3cef16a3d9b96608bc67c4b30db88e0a5a6c6390213f7acbe1153ff6d23ce57380104288ae19373ef@127.0.0.1:21000?discport=0&raftport=50401", "enode://0ba6b9f606a43a95edc6247cdb1c1e105145817be7bcafd6b2c0ba15d58145f0dc1a194f70ba73cd6f4cdd6864edc7687f311254c7555cc32e4d45aeb1b80416@127.0.0.1:21001?discport=0&raftport=50402", "enode://579f786d4e2830bbcc02815a27e8a9bacccc9605df4dc6f20bcc1a6eb391e7225fff7cb83e5b4ecd1f3a94d8b733803f2f66b7e871961e7b029e22c155c3a778@127.0.0.1:21002?discport=0&raftport=50403", "enode://3d9ca5956b38557aba991e31cf510d4df641dce9cc26bfeb7de082f0c07abb6ede3a58410c8f249dabeecee4ad3979929ac4c7c496ad20b8cfdd061b7401b4f5@127.0.0.1:21003?discport=0&raftport=50404", "enode://3701f007bfa4cb26512d7df18e6bbd202e8484a6e11d387af6e482b525fa25542d46ff9c99db87bd419b980c24a086117a397f6d8f88e74351b41693880ea0cb@127.0.0.1:21004?discport=0&raftport=50405", "enode://eacaa74c4b0e7a9e12d2fe5fee6595eda841d6d992c35dbbcc50fcee4aa86dfbbdeff7dc7e72c2305d5a62257f82737a8cffc80474c15c611c037f52db1a3a7b@127.0.0.1:21005?discport=0&raftport=50406", "enode://239c1f044a2b03b6c4713109af036b775c5418fe4ca63b04b1ce00124af00ddab7cc088fc46020cdc783b6207efe624551be4c06a994993d8d70f684688fb7cf@127.0.0.1:21006?discport=0&raftport=50407" ]Permissions の有効化/無効化

個々のノードは、gethを立てる際に

-permissionedコマンドラインフラグを渡すことで許可を有効または無効にできます。

有効になっている場合、<datadir>/permissioned-nodes.jsonのノードのみが接続できます。

さらに、これらは、このノードがアウトバウンド接続を行うことができる唯一のノードです終わりに

サンプルだけでは少々物足りないですね。

もっと調査します。

- 投稿日:2020-02-28T10:07:02+09:00

Dockerコンテナ内でpingを実行するための備忘録

pingコマンドが実行できなかったため、以下でインストールしようとしましたが、できませんでした。

apt-get install iputils-pingエラー、、、

E: Unable to locate package iputils-ping E: Unable to locate package net-tools以下で、インストール可能なパッケージの一覧を最新にしたのち、再びインストールを行ったらできました。

apt-get update

- 投稿日:2020-02-28T06:32:34+09:00

Docker Desktop for Windows (参考訳)

Docker Desktop for Windows

目次

- Docker for Windowsを始めよう

- WIndows に Docker Desktop をインストール

- Docker Desktop ダッシュボード

- Kubernetes 上にデプロイ

- Docker Desktop for Windowsのネットワーク構築機能

- Docker Toolboxの移行

- ログとトラブルシューティング

- FAQ

- Docker Desktop WSL2 バックエンド

- 原文へのリンク

Docker for Windows を始めよう

Docker Desktop へようこそ!

Docker Desktop for Windows のセクションで扱う情報は、Docker Desktop コミュニティ安定版リリース(Community Stable release)に関してです。エッジリリース(Edge release)に関する情報は、 エッジリリースノートを御覧ください。Docker デスクトップ・エンタープライズ(DDE)リリースに関する情報は Docker Desktop Enterprise を御覧ください。

Docker とは、コンテナ化したアプリケーションを構築・実行・共有するための、全てが揃った開発プラットフォームです。Windows 上で Docker を使い始めるためには、Docker Desktop が最も良い方法です。

ダウンロード情報、システム要件、インストール手順については、 Docker Desktop のインストール を御覧ください。

インストールの確認

- ターミナルウインドウを開きます(コマンドプロンプトか PowerShellの場合 。ただし、PowerShell ISE は除く)。

docker --versionを実行し、サポート対象の Docker かどうかを確認します。> docker --version Docker version 19.03.13. hello-world イメージ を Docker Hub から取得し、コンテナとして実行します。

> docker run hello-world docker : Unable to find image 'hello-world:latest' locally latest: Pulling from library/hello-world 1b930d010525: Pull complete Digest: sha256:c3b4ada4687bbaa170745b3e4dd8ac3f194ca95b2d0518b417fb47e5879d9b5f Status: Downloaded newer image for hello-world:latest Hello from Docker! This message shows that your installation appears to be working correctly. ...4. Docker Hub からダウンロードした

hello-worldイメージを、一覧から確認します。> docker image ls5.

hello-worldコンテナを一覧に表示します("Hello from Docker!" を表示した後、終了 exited しています)。> docker container ls --all6. いくつかのヘルプ命令を実行し、Docker ヘルプページを見て回ります。

> docker --help > docker container --help > docker container ls --help > docker run --helpアプリケーションを試す

このセクションでは、OS やウェブサーバといった複雑なアプリケーションを実行し、Docker 化アプリケーションの簡易さと威力をお見せします。

- Ubuntu OS のイメージを取得し、作成したコンテナ内で、双方向(インタラクティブ)のターミナルを実行します。

> docker run --interactive --tty ubuntu bash docker : Unable to find image 'ubuntu:latest' locally latest: Pulling from library/ubuntu 22e816666fd6: Pull complete 079b6d2a1e53: Pull complete 11048ebae908: Pull complete c58094023a2e: Pull complete Digest: sha256:a7b8b7b33e44b123d7f997bd4d3d0a59fafc63e203d17efedf09ff3f6f516152 Status: Downloaded newer image for ubuntu:latest**PowerShell ISE を使用しないでください* 双方向ターミナルは PowerShell ISE では動作しません(PowerShell では動作します)。詳細は docker/for-win/issues/223 を御覧ください

2. コンテナの中にいます。ルート

#プロンプト上で、コンテナのhostname(ホスト名)を確認します。root@8aea0acb7423:/# hostname 8aea0acb7423ホスト名には、コンテナ ID が割り当てられているのに注目します(プロンプトでもホスト名にコンテナ ID が用いられています)。

3.

exitコマンドでシェルを終了します(また、コンテナも停止します)。root@8aea0acb7423:/# exit >4.

--allオプションを付けて、コンテナ一覧を表示します(実行中のコンテナが存在しないからです)。

hello-worldコンテナ(ランダムにrelaxed_sammetと名前付け)は、自身のメッセージを表示した後、停止しました(stopped)。ubuntuコンテナ(ランダムにlaughing_kowalevskiと名前付け)は、コンテナから抜け出た(exit)ので停止しました(stopped)。> docker container ls --all CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 8aea0acb7423 ubuntu "bash" 2 minutes ago Exited (0) 2 minutes ago laughing_kowalevski 45f77eb48e78 hello-world "/hello" 3 minutes ago Exited (0) 3 minutes ago relaxed_sammet5. Docker 化した nginx (エンジンエックス)ウェブ・サーバを取得・実行し、

webserverと名付けます。> docker run --detach --publish 80:80 --name webserver nginx Unable to find image 'nginx:latest' locally latest: Pulling from library/nginx fdd5d7827f33: Pull complete a3ed95caeb02: Pull complete 16f7a5f3082: Pull complete 7b10f03a0309: Pull complete Digest: sha256:f6a001272d5d324c4c9f3f183e1b69e9e0ff12debeb7a092730d638c33e0de3e Status: Downloaded newer image for nginx:latest dfe13c68b3b86f01951af617df02be4897184cbf7a8b4d5caf1c3c5bd3fc267f6. ウェブ・ブラウザで

http://localhostを指定し、nginx のスタートページを開きます(:80を追加する必要はありません。dockerコマンドで標準の HTTP ポートを指定したからです)。<図>

7. 実行中( running )のコンテナのみを一覧表示します。

> docker container ls CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 0e788d8e4dfd nginx "nginx -g 'daemon of…" 2 minutes ago Up 2 minutes 0.0.0.0:80->80/tcp webserver8. 実行中の nginx コンテナを停止するために、割り当てた

webserverの名前を使います。> docker container stop webserver9. 3つのコンテナ全てを、名前で削除します。後ろにある2つの名前は、おそらく皆さんの環境とは異なるでしょう。

> docker container rm webserver laughing_kowalevski relaxed_sammetDocker 設定画面(ダイアログ)

Docker Desktop のメニュー から、インストール、アップデート、バージョンチャンネル、Docker Hub へのログインなど、Docker の設定ができます。

このセクションでは、 Settings (設定)画面から設定できるオプションについて説明します。

1. Docker Desktop のメニューを開くには、通知エリア(又はシステムトレイ)にある Docker アイコンをクリックします。

<図>

2. 設定画面から Settings (設定)を選びます。

<図>

General(一般的な設定)

設定画面の General タブでは、Docker の起動と更新を設定できます。

<図>

- Start Docker when you log in - Windows システムへのログイン時、自動的に Docker Desktop を起動します。

- Automatically check for updates - デフォルトでは、Docker Desktop は自動的に更新を確認し、更新版が利用可能な場合は通知します。承諾して更新版をインストールするには OK をクリックします(あるいは、現在のバージョンを維持する場合は、キャンセルします)。メインの Docker メニューから Check for Updates (更新を確認)で、手動での更新ができます。

- Expose daemon on tcp://localhost:2357 without TLS - レガシー(古い)クライアントが Docker デーモンに接続できるようにするには、このオプションを有効化します。このオプションを使う場合は注意が必要です。TLS なしでデーモンを公開する場合は、リモートからのコード実行攻撃をもたらす可能性があるためです。

- Send usage statics - デフォルトでは、Docker Desktop は診断情報・クラッシュ報告・利用データを送信します。この情報は、 Docker の改善やアプリケーションの問題解決に役立ちます。止めるにはチェックボックスを空にします。Docker は定期的に更なる情報を訊ねるかもしれません。

Resources(リソース)

Resources タブは、CPU、メモリ、ディスク、プロキシ、ネットワーク、その他のリソースを設定できます。

<図>

ADVANCED(高度な設定)

Advanced タブでは、 Docker が利用できるリソースに制限をかけます。

- CPUs (CPU): デフォルトでは、 ホスト・マシン上で利用可能なプロセッサ数の半分を、Docker Desktop が使います。総理能力を向上するには、この値を高くします。減らすには、数値を低くします。

- Memory (メモリ): デフォルトでは、 マシン上で利用可能な全メモリから

2GB の実行メモリを使用する設定です。RAM を増やすには、この値を高くします。減らすには、値を低くします。- Swap (スワップ): 必要になるスワップ・ファイル容量を設定します。デフォルトは 1 GB です。

- Disk image size (ディスク・イメージ容量): ディスク・イメージの容量を指定します。

- Disk image location (ディスク・イメージの場所): Linux ボリュームの場所を指定します。ここにコンテナとイメージを置きます。

また、ディスク・イメージは別の場所に移動できます。ディスク・イメージの指定先に既にイメージがある場合は、既存のイメージを使うか置き換えるか訊ねる画面を表示します。

FILE SHARING(ファイル共有)

Linux コンテナと共有したいローカルのディレクトリを選択します。ファイル共有は Linux コンテナ内でボリュームをマウントするために必要であり、Windows コンテナ用ではありません。Linux コンテナでは、Dockerfile とボリュームを保管するための場所として、ドライブの共有が必要です。指定がなければ、実行時に

file not found(ファイルが見つかりません)やcannot start service(サービスを開始できません)のエラーが出ます。詳しくは「Linux コンテナのボリューム・マウントには共有ドライブが必要」を御覧ください。ファイル共有権限は、ここで指定した場所に認証情報(credential)の設定を試みます。この場所に対しては、設定済みの異なるユーザ名で

dockerコマンドを実行しても、コンテナはマウントされたボリュームに対してアクセスできません。コンテナに共有したいローカル・ドライブを指定したら、 Docker Desktop は Windows システム(ドメイン)のユーザ名とパスワードの入力を求めます。認証情報を入力の後、 Apply & Restart (適用と再起動)をクリックします。

共有ドライブ、権限、ボリューム・マウントに役立つ情報

- 可能であれば、Windows ホストからボリューム・マウントするのではなく、その代わりに Linux VM 上をマウントします。あるいはデータ・ボリューム(名前付きボリューム)やデータ・コンテナを使います。ホストをマウントするボリュームや、データベース・ファイルにネットワーク・パスを用いる場合、多数の問題があります。詳細は「ホスト・パスでボリュームのマウントでは、データベース・ロックを上書きする nobrl オプションを使う」を御覧ください。

- Docker Desktop はユーザ、グループ、その他に対する読み込み/書き込み/実行権限を 0777 あるいは a+rwx に設定します。これは調整できません。詳細は「共有ボリュームにおけるデータ・ディレクトリ上の権限エラー」を御覧ください。

- ドメイン・ユーザは共有ドライブにアクセスできるようにしてください。詳細な情報は「ドメイン・ユーザは共有ドライブに対する権限があるかどうか確認」を御覧ください。

- コンテナに対してはローカル・ドライブを共有可能ですが、Docker Machine ノードに対してではありません。詳細は FAQ の「Docker Machine 用仮想マシンでローカル・ドライブとファイルシステムを共有できますか?」を御覧ください。FIREWALL RULES FOR SHARED DRIVES(共有ドライブのファイアウォール・ルール)

ホストマシンと Linux コンテナを実行する仮想マシン間では、ドライブの共有にポート 445 のオープンが必要です。共有ドライブの追加ときに、Docker でポート 445 が閉じられているのを検出したら、以下のメッセージを表示します。

<図>

ドライブを共有するには、Windows ファイアウォールやサードパーティ製のファイアウォール・ソフトウェアで、Windows ホストマシンと仮想マシン間での通信を可能にします。ポート 445 以外のネットワークは、一切開く必要がありません。

デフォルトでは、

10.0.75.2(仮想マシン)から10.0.75.1上のポート 445(Windows ホスト)へと通信します。もしもファイアウォールのルールが正しければ、Hyper-V 仮想ネットワーク・カード上のファイルと印刷共有サービスの切り替え又は再インストールが必要になるかもしれません。SHARED DRIVES ON DEMAND(オンデマンド共有ドライブ)

個々のマウントが必要な場合、初回に "オンデマンド" でドライブを共有できます。

シェルでボリューム・マウント(以下に例があります)する Docker コマンドの実行時や、Compose ファイルで立ち上げ時にボリューム・マウントがあれば、特定のドライブを共有するかどうか訊ねるポップアップが現れます。

Share it (共有する)を選択でき、Docker Desktop の「共有ドライブ一覧」にあるいずれかを、コンテナで利用可能になります。あるいは、共有したくない場合には Cancel (中止)を選べます。

<図>

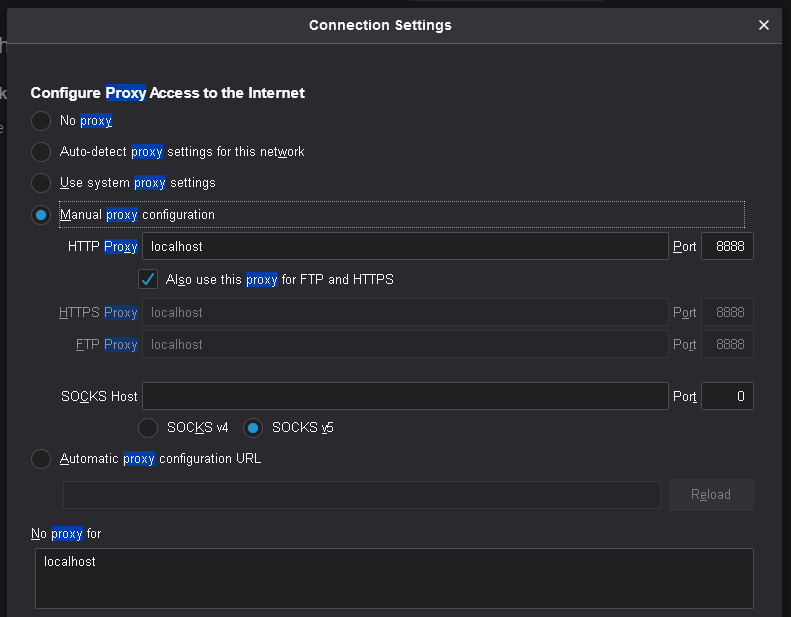

PROXIES(プロキシ)

Docker Desktop は、HTTP/HTTPS プロキシ設定を調整し、自動的に Docker とコンテナに対して情報を伝達(propagate)します。例えば、

http://proxy.example.comに対してプロキシ設定をすると、Docker はコンテナの取得時にこのプロキシを使います。コンテナが実行中であれば、コンテナ内にプロキシ設定が伝わっているかどうか確認できます。例:

> docker run alpine env PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin HOSTNAME=b7edf988b2b5 TERM=xterm HOME=/root HTTP_PROXY=http://proxy.example.com:3128 http_proxy=http://proxy.example.com:3128 no_proxy=*.local, 169.254/16こちらの結果では、

HTTP_PROXY、http_proxy、no_proxy環境変数が設定されているのが分かります。プロキシ設定を変更した場合は、新しい設定を適用するために、Docker は自動的に再起動します。再起動後もコンテナを実行し続けたい場合には、「再起動ポリシー」の利用を検討すべきでしょう。NETWORK (ネットワーク)

Docker Desktop のネットワーク機能を、仮想プライベート・ネットワーク(VPN)でも機能するように設定できます。インターネットとの疎通を有効にするには、ネットワーク・アドレス変換(NAT)プリフィックスとサブネットマスクを設定します。

DNS Server (DNS サーバ) : DNS サーバには、動的 IP アドレスか固定 IP アドレスを設定できます。

メモ : 何人かの利用者から、 Docker Desktop の安定バージョンで Docker Hub との通信問題が報告されています。これは

dockerコマンドの実行を試みるとき、Docker Hub からイメージを未ダウンロードであれば、エラーが確実に発生します。例えば、docker run hello-worldの初回実行時です。このような現象になれば、DNS サーバをリセットし、Google DNS の固定アドレス8.8.8.8を指定します。詳しい情報は「ネットワーク機能の問題」にあるトラブルシューティングを御覧ください。以上の情報の更新するには、設定の変更と Linux VM の再起動が必要です。

Docker Engine (Docker エンジン)

Docker Engine のページでは、Docker デーモンの設定や、どのようにしてコンテナを実行するかを決められます。

デーモンの設定をするには、テキストボックス内に JSON 形式の設定ファイルとして入力します。オプションの一覧については、 Docker Engine dockerd コマンドライン・リファレンス を御覧ください。

Apply & Restart (適用と再起動)をクリックし、設定を保存して Docker Desktop を再起動します。

Command Line (コマンドライン)

コマンドラインのページでは、experimental features(実験的機能)を有効にするかどうかを指定できます。

Docker Desktop Edge と Stable リリースのいずれでも、実験的機能の有効化と無効化を切り替えできます。実験的機能を無効化すると、Docker Desktop は現時点の Docker エンジン安定版リリースを使います。

実験的機能

Docker Desktop Edge リリースは、デフォルトで Docker エンジンの実験的なバージョンが有効です。詳細は Git Hub 上の Docker 実験的機能 README(英語) を御覧ください。

実験的機能は、今後提供する機能を先行利用できます。各機能は、テストやフィードバックを意図した、参考程度のものです。そのため、リリース時までに警告が出たり、今後のリリースでは削除されたりする場合があります。本番向けの環境では、実験的機能を決して使わないでください。Docker は実験的機能に対するサポートを提供していません。

Tips: Docker コマンドラインツールで実験的機能を有効にするには、

config.jsonファイルを編集し、experimentalを有効化するよう指定します。

Docker Desktop のメニューから実験的機能を有効にするには、 Settings (設定) → Command Line (コマンドライン)をクリックし、 Enable experimental features (実験的機能の有効化)ボタンを押します。 Apply & Restart (適用と再起動)をクリックします。実験的機能が有効かどうかを確認するには、

docker versionを実行します。実験的モードはServerデータ下の一覧に状態があります。もしも以下のようにExperimental(実験的)がtrue(真)であれば、Docker は実験的モードで動作しています。> docker version Client: Docker Engine - Community Version: 19.03.1 API version: 1.40 Go version: go1.12.5 Git commit: 74b1e89 Built: Thu Jul 25 21:17:08 2019 OS/Arch: windows/amd64 Experimental: true Server: Docker Engine - Community Engine: Version: 19.03.1 API version: 1.40 (minimum version 1.12) Go version: go1.12.5 Git commit: 74b1e89 Built: Thu Jul 25 21:17:52 2019 OS/Arch: linux/amd64 Experimental: true containerd: Version: v1.2.6 GitCommit: 894b81a4b802e4eb2a91d1ce216b8817763c29fb runc: Version: 1.0.0-rc8 GitCommit: 425e105d5a03fabd737a126ad93d62a9eeede87f docker-init: Version: 0.18.0 GitCommit: fec3683Kubernetes

Docker Desktop には単独の Kubernetes サーバを含みます。Kubernetes は Windows ホスト上で実行できますので、Kubernetes 上に Docker ワークロードを試験的にデプロイできます。

<図>

Kubernetes クライアント・コマンドの

kubectlが組み込まれており、ローカルの Kubernetes サーバに接続するよう設定済みです。もしも既にkubectlをインストール済みで、minikubeや GKE クラスタのような他の環境を向いている場合は、kubectlがdocker-for-desktopを指し示すように切り替わっているかどうか確認します。> kubectl config get-contexts > kubectl config use-context docker-for-desktopKubernetes サポートを有効化し、Kubernetes の独立したインスタンスを Docker コンテナとしてインストールするには、 Enable Kubernetes (Kubernetes 有効化)をクリックします。

Kubernetes を デフォルトのオーケストレータ として設定するには、 Deploy Docker Stacks to Kubernetes by default (Docker Stack のデプロイをデフォルトで Kubernetes にする)を選びます。

デフォルトで、Kubernetes コンテナは

docker service lsのようなコマンドで非表示です。この理由は、手動での(Kubernetes)管理がサポートされていないからです。これらを表示するには Show system containers (advances) (システムコンテナの表示〔高度〕)を選びます。多くの利用者には不要なオプションです。Apply & Restart (適用と再起動)をクリックし、設定を保存します。 Kubernetes サーバをコンテナとして実行するために必要なイメージが実体化(インスタンス化)され、

kubectl.exeコマンドがパス上にインストールされます。

- Kubernetes を有効化して実行している場合は、Docker Desktop 設定ダイアログの右横に、ステータス・バーの追加アイテムを表示します。Docker メニューの Kubernetes のステータスは、作業対象を

docker-desktopと表示します。- Enable Kubernetes (Kubernetes 有効化)のチェックボックスをクリアしたら、Kubernetes サポートはいつでも無効にできます。無効により、この Kubernetes コンテナを停止及び削除し、

/usr/local/bin/kubectlコマンドも削除します。- 全てのスタックと Kubernetes リソースを削除するには、 Reset Kubernetes Cluster (Kubernetes クラスタのリセット)を選びます。

- 他の方法で

kubectlをインストールした場合は、競合が発生し、削除されます。Docker Desktop で Kubernetes 統合機能を使う詳しい情報は、 Kubernetes 上にデプロイ を御覧ください。

リセット

Troubleshoot (トラブルシュート)のメニュー上から、 Restart Docker Desktop (Dockerデスクトップの再起動)と Reset to factory defaults (初期値にリセットする)オプションを利用できます。詳しい情報は ログとトラブルシューティング を御覧ください。

トラブルシュート

詳細は ログとトラブルシューティング ガイドを御覧ください。

Docker Desktop for Windows フォーラム(英語) にログオンしたら、コミュニティからの手助けを得たり、利用者のトピックを参照したり、議論に参加できます。

GitHub 上の Docker Desktop for Windows issues(英語) にログオンし、バグや問題の報告や、コミュニティに報告された問題を参照できます。

ドキュメントに対するフィードバックの仕方や自分で更新するには ドキュメント貢献(英語) を御覧ください。

Windows と Linux コンテナとの切り替え

Docker Desktop のメニューから、Docker CLI が通信するデーモン(Linux か Windows)を切り替えできます。 Switch to Windows containers (Windows コンテナへ切り替え)を選ぶと Windows コンテナを使います。又は、 Switch to Linux containers (Linux コンテナへ切り替え)を選ぶと Linux コンテナを使います(こちらがデフォルト)。

Windows コンテナに関する詳しい情報は、以下のドキュメントを参照ください(※リンク先はいずれも英語)。

- Windows containers にあるマイクロソフトのドキュメント

- Build and Run Your First Windows Server Container (ブログ投稿) では、Windows 10 と Windows Server 2016 evaluation リリースで、ネイティブな Docker Windows コンテナを構築・実行するクイック・ツアーを提供しています。

- Getting Start with Windows Containers(Lab)(英語) では、MusicStore の Windows コンテナ アプリケーションの使い方を紹介します。MusicStore は標準的な .NET アプリケーションであり、 コンテナを使うものをコチラからフォーク できます。これは複数コンテナ・アプリケーションの良い例です。

Docker Hub

自分の Docker Hub アカウントにアクセスするには、Docker Desktop のメニューから「Sing in/Create Docker ID」(サインイン/Docker ID 作成)を選びます。一度ログインしておけば、Docker Desktop のメニューから Docker Hub リポジトリに直接アクセス可能になります。

詳しい情報は、以下の Docker Hub 記事(英語) を御覧ください。

二要素認証

Docker Desktop では、Docker Hub へのログインに二要素認証(Two-factor authentication)を有効化できます。二要素認証は Docker Hub アカウントにアクセスするとき、追加のセキュリティ段階を提供します。

Docker Hub での二要素認証を有効化する前に、Docker Desktop を通して Docker Hub アカウントにサインインする必要があります。手順は Docker Hub で二要素認証を有効にする(英語) を御覧ください。

二要素認証を有効化した後、

- Docker Desktop のメニューから「 Sign in / Create Docker ID 」を選択。

- Docker ID とパスワードを入力し、 Sign in (サインイン)をクリック。

- サインインに成功した後、 Docker Desktop で認証コード(authentication code)の入力を求める画面が開きます。電話に届いた6桁のコードを入力し、 Verify (確認)をクリックします。

<図>

認証に成功したら、Docker Desktop のメニューから organization やリポジトリにアクセス可能になります。

TLS 証明書の追加

Docker デーモンが、レジストリ・サーバ証明書と クライアント証明書 の検証用に、信頼できる 認証局(CA; Certificate Authorities) を追加してレジストリを認証できます。詳しい情報は FAQ にある 任意の CA 証明書を追加できますか? と クライアント証明書の追加はどのように行いますか? を御覧ください。

どのようにしてカスタム CA 証明書を追加できますか?

Docker Desktop は全ての信頼できうる(ルート及び中間)証明局(CA)をサポートしています。証明書が信頼できるルート認証局や中間認証局の配下にあるかどうか、Docker は識別します。

Docker Desktop は Windows 証明局ストアに基づき、全てのユーザが信頼する CAの証明書バンドルを作成します。また、Moby の信頼できる証明書にも適用します。そのため、エンタープライズ SSL 証明書がホスト上のユーザによって信頼されている場合は、Docker Desktop からも信頼されます。

レジストリに対する CA ルート証明書のインストール方法について学ぶには、Docker エンジン記事の 証明書でリポジトリ・クライアントを認証する(英語) を御覧ください。

どのようにしてクライアント証明書を追加しますか?

自分のクライアント証明書を

~/.docker/certs.d/<MyRegistry>:<Port>/client.certと~/.docker/certs.d/<MyRegistry>:<Port>/client.keyに追加できます。自分の証明書をgitコマンドで送信する必要はありません。Docker Desktop ・アプリケーションの開始時に、 Windows システム上の

~/.docker/certs.dフォルダを Moby 上(Hyper-V 上で稼働する Docker Desktop 仮想マシン)の/etc/docker/certs.dディレクトリにコピーします。キーチェーンに対する何らかの変更をするか、

~/.docker/certs.dディレクトリ内の変更を有効にするには、 Docker Desktop の再起動が必要です。レジストリは insecure (安全ではない)レジストリとして表示されません( Docker デーモン(英語) を御覧ください )。Docker Desktop は安全ではないレジストリにある証明書を無視します。そして、クライアント証明書も送信しません。

docker runのようなレジストリから取得するコマンドは、コマンドライン上でもレジストリでもエラーになるメッセージが出ます。認証用にクライアント TLS 証明書を設定する方法を学ぶには、Docker エンジン記事の 証明書でリポジトリ・クライアントを確認する(英語) を御覧ください。

Window に Docker Desktop をインストール

Docker Desktop for Windows は、Microsoft Windows用の Docker コミュニティ 版です。Docker Desktop for Windows は Docker Hub からダウンロードできます。

Docker Desktop のダウンロード中に、 Docker Software End User License Agreement と Docker Data Processing Agreement に同意ください。

インストール前に知っておくこと

システム要件

- Windows 10 64 ビット:Pro、Enterprise、Education(ビルド 15063 以上)

- Hyper-V と Windows コンテナ機能の有効化が必要

- 以下は、Windows 10 以上で Hyper-V クライアントを問題なく実行するために必要なハードウェア要件

- 64 ビット SLAT (Second Level Address Translation) 対応プロセッサ

- 4GB システムメモリ

- BIOS レベルでのハードウェア仮想化が、BIOS 設定で有効にする必要。詳細な情報は 仮想化 を参照

メモ : Docker による Windows 用 Docker Desktop のサポートは、Microsoft の Windows 10 オペレーティングシステムに対するサポート・ライフサイクルに基づきます。詳細な情報は Windows ライフサイクル・ファクトシート を御覧ください。

Docker Toolbox 及び Docker Machine 利用者の方へ

Microsoft Hyper-V が Docker Desktop 実行のために必要です。Docker Desktop Windows のインストーラは、必要であれば Hyper-V を有効化し、マシンを再起動します。しかしながら、作成済みの VirtualBox VM イメージは保持し続けます。

docker-machineで作成した VirtualBox 仮想マシンは(Toolbox インストール中に、通常はdefaultという名称の仮想マシン)、起動できなくなります。各仮想マシンは Docker Desktop と共存して利用できません。しかしながら、docker-machineを使ってリモートの仮想マシンの削除は可能です。インストーラに含まれるもの

Docker Desktop のインストールに含まれるのは、 Docker Engine 、 Docker CLI クライアント、 Docker Compose 、 Notary 、 Kubernetes 、Credential Helper です。

VMware や Parralles インスタンス上で Docker Desktop を実行するような、ネストした仮想化でも動くでしょうが、無保証です。詳しい情報は ネスト対応の仮想化シナリオ を御覧ください。

メモ : Windows サーバに関する全ての Docker 互換性比較は、 Docker 互換表 を御覧ください。

Windows コンテナについて

Windows コンテナの情報をお探しですか?

- Windows と Linux コンテナの切り替え では、Docker Desktop での Linux と Windows コンテナ間の切り替え方を説明し、上の方でチュートリアルに言及しています。

- Getting Started with Windows Containers (Lab) では、セットアップと Windows コンテナを実行するためのチュートリアルを提供しています。対象は Windows 10、Windows Server 2016、Windows Server 2019 です。そちらでは Windows コンテナで MusicStore アプリケーションを扱う方法を説明します。

- Windows 用 Docker コンテナ・プラットフォームについては、 Docker ウェブサイト上の 記事やブログ投稿 を御覧ください。

Windows に Docker Desktop をインストール

- 「 Docker Desktop Installer.exe 」をダブルクリックし、インストーラを起動します。もしもまだインストーラ(

Docker Desktop Installer.exe)をダウンロードしていなければ、 Docker Hub から取得できます。- インストール・ウィザードの指示に従い、利用規約(ライセンス)を承諾し、インストーラに権限を与えてインストールを進めます。インストール途中で、Docker Desktop のインストーラに対してシステムパスワードの確認プロンプトが表示されたら、権限を与えます。ネットワーク機能のコンポーネントをインストールするには、特権アクセスが必要です。ネットワーク機能は、Docker アプリケーションと管理用 Hyper-V 仮想マシンをつなげるためです。

- セットアップ完了ダイアログの「 Finish 」(完了)をクリックし、Docker Desktop ・アプリケーションを起動します。

Docker Desktop を始める

インストール後の Docker Desktop は、自動的に起動できません。Docker Desktop を開始するには Docker を検索し、検索結果にある「 Docker Desktop 」を選択します。

<図>

ステータス・バーに鯨のアイコンが出続けたら、 Docker Desktop は起動・実行中であり、あらゆる端末ウインドウからアクセスできます。

<図>

もしも鯨アイコンが通知エリアから隠れている場合は、タスクバーで「上」を向いた矢印をクリックして表示します。詳しく知るには [Docker 設定] を御覧ください。

Docker Desktop アプリのインストール後は、成功のメッセージと、次のステップの提案もポップアップし、このドキュメント(英語版)のリンクを表示します。

<図>

インストールが完了したら、通知エリアにある鯨アイコンをクリックし、 About Docker Desktop (Docker Desktop について)を選び、最新版がインストールされているか確認します。

おめでとうございます! Windows 版 Docker Desktop の実行に成功しました。

Docker Desktop のアンインストール

Windows マシンから Docker Desktop をアンインストールするには、

- Windows の スタート メニューから、 設定 > アプリ > アプリと機能 を選びます。

- アプリと機能 の一覧から Docker Desktop を選択し、 アンインストール をクリックします。

- 選択したのを確認の後、 アンインストール をクリックします。

メモ : Docker Desktop のアンインストールは、ローカルのマシンにある Docker コンテナのイメージを破棄し、アプリケーションによって作成された全てのファイルも破棄します。

Stable と Edge バージョンの切り替え

Docker Desktop は、自分で Stable (安定版)リリースと Edge (最新)リリースを切り替え可能です。しかしながら、 Docker Desktop を一度にインストールできるのは、1つのバージョンのみ です。Stable と Edge 版のリリース切り替えるは、開発環境の安定性を損なう可能性があります。特に、新しい(Edge)チャンネルを古い(Stable)チャンネルに切り替える場合です。

例えば、 Docker Desktop の新しい Edge バージョンでコンテナを作成する場合、Stable に切り戻すと動作しなくなる可能性があります。これは、Edge の機能を使って作成したコンテナには、まだ Stable には反映されていない機能が用いられている場合があるからです。Edge コンテナで作成したり作業したりする場合には、留意し続けてください。

Edge と Stable バージョン間を安全に切り替えるには、必要に応じてイメージの保存(save)やコンテナの出力(export)を確実に行い、他のバージョンをインストールする前に、既存のバージョンをアンインストールします。詳しい情報については、以下にあるデータの保存と修復を御覧ください。

データの保存と修復

以下の手順を用いて、イメージとコンテナのデータを保存・修復できます。例えば、Edge と Stable を切り替えたいときや、仮想マシンのディスクをリセットしたいときに用います。