- 投稿日:2020-01-22T23:29:44+09:00

docker-compose で Cloud Datastore Emulatorを立ち上げpythonアプリと連携する

背景

サービスでdatastoreを使う事になり、開発環境やCIでのテストをどうするか試行錯誤した。

AWSと比較して情報が少ないので、まとめた。

要点

- flaskアプリとCloud Datastore Emulatorをコンテナを作る

- docker-composeでサービス連携を行う

- datastoreの初期データ投入

- flaskアプリから、Cloud Datastore Emulatorを操作する

ディレクトリ構成

. ├── app │ ├── Dockerfile │ └── src │ ├── main.py │ └── requirements.txt ├── datastore │ ├── Dockerfile │ ├── entrypoint │ └── import │ ├── 2020-01-21.overall_export_metadata │ ├── default_namespace │ │ └── kind_test_data │ │ ├── default_namespace_kind_test_data.export_metadata │ │ └── output-0 │ └── run.sh └── docker-compose.yamlCloud Datastore Emulator コンテナ構築

datastore/Dockerfile

公式のSDKイメージから最小限で作成。

エミュレータ起動用shell、データ投入用shellに実行権限付与。FROM google/cloud-sdk:alpine RUN apk add --update --no-cache openjdk8-jre \ && gcloud components install cloud-datastore-emulator beta --quiet COPY . /datastore/ WORKDIR /datastore RUN chmod +x ./entrypoint RUN chmod +x ./import/run.sh ENTRYPOINT ["./entrypoint"]datastore/entrypoint

docker-compose downした際にも、データを維持するために、/datastore/.data/ディレクトリにデータをためる。オプションなしで起動すると、コンテナ内でしかアクセスできないので、

--host-port=0.0.0.0:8081として起動する。

環境変数から、プロジェクト名と一緒に流し込む。#!/usr/bin/env bash gcloud config set project ${DATASTORE_PROJECT_ID} gcloud beta emulators datastore start \ --data-dir=/datastore/.data \ --host-port=${DATASTORE_LISTEN_ADDRESS}データ投入のdatastore/import/run.sh

サーバー起動後、下記のエンドポイントにdump済みのデータの保存パスを投げるとデータがインポートできる。

export DATASTORE_PROJECT_ID curl -X POST localhost:8081/v1/projects/${DATASTORE_PROJECT_ID}:import \ -H 'Content-Type: application/json' \ -d '{"input_url":"/datastore/import/2020-01-21.overall_export_metadata"}'datastore/importのメタデータ

今回は、gcp のコンソールから、gcsにダンプしたデータをディレクトリ丸ごと

datastore/import配下に持ってきた。

sdkデータを直接生成してもよい。python アプリ コンテナ構築

サンプル用にペラペラのアプリ構築する。

app/Dockerfile

FROM python:3.7-slim-buster ENV HOME /api/ ADD ./ ${HOME} WORKDIR ${HOME} RUN pip install --upgrade pip \ && pip install --no-cache-dir -r ${HOME}src/requirements.txt ENTRYPOINT ["python", "src/main.py"]app/main.py

ちょっと適当すぎる気がするが、データを保存して取り出すだけのエンドポイントを作成。

認証情報は、ダミーの認証をかませる。

from flask import Flask, jsonify from google.auth.credentials import AnonymousCredentials from google.cloud import datastore from os import getenv client = datastore.Client( credentials=AnonymousCredentials(), project=getenv('PROJECT_ID') ) app = Flask(__name__) app.config['JSON_AS_ASCII'] = False @app.route('/') def index(): key = client.key('EntityKind', 1234) entity = datastore.Entity(key=key) entity.update({ 'foo': u'bar' }) client.put(entity) result = client.get(key) return jsonify(result) if __name__ == '__main__': app.run(host='0.0.0.0')app/requirements.txt

Flask==1.1.1 google-auth==1.6.2 google-cloud-datastore==1.8.0docker-compose.yaml

datastoreのポートは、ホスト側にも開けておくと、GUIツールで見ることができて便利

https://github.com/GabiAxel/google-cloud-gui

version: '3.7' x-custom: gcp: - &gcp_project_id "dummy" services: app: build: "./app/" volumes: - "./app/:/app/" environment: FLASK_APP: dev DATASTORE_HOST: "http://datastore:8081" DATASTORE_EMULATOR_HOST: "datastore:8081" PROJECT_ID: *gcp_project_id TZ: Asia/Tokyo ports: - "5000:5000" depends_on: - datastore datastore: build: "./datastore" volumes: - "./datastore/.data:/datastore/.data" environment: DATASTORE_PROJECT_ID: *gcp_project_id DATASTORE_LISTEN_ADDRESS: 0.0.0.0:8081 ports: - "18081:8081"起動

docker-compose upブラウザやcurlで、http://localhost:5000にアクセスすると{"foo": "bar"}と表示されるはず。

ログ

下記にデータが貯められてるのがわかる

/datastore/.data/WEB-INF/appengine-generated/local_db.bin

datastore_1 | Updated property [core/project]. datastore_1 | WARNING: Reusing existing data in [/datastore/.data]. datastore_1 | Executing: /google-cloud-sdk/platform/cloud-datastore-emulator/cloud_datastore_emulator start --host=0.0.0.0 --port=8081 --store_on_disk=True --consistency=0.9 --allow_remote_shutdown /datastore/.data app_1 | * Serving Flask app "main" (lazy loading) app_1 | * Environment: production app_1 | WARNING: This is a development server. Do not use it in a production deployment. app_1 | Use a production WSGI server instead. app_1 | * Debug mode: off app_1 | * Running on http://0.0.0.0:5000/ (Press CTRL+C to quit) datastore_1 | [datastore] Jan 22, 2020 6:22:00 AM com.google.cloud.datastore.emulator.CloudDatastore$FakeDatastoreAction$9 apply datastore_1 | [datastore] INFO: Provided --allow_remote_shutdown to start command which is no longer necessary. datastore_1 | [datastore] Jan 22, 2020 6:22:01 AM com.google.cloud.datastore.emulator.impl.LocalDatastoreFileStub <init> datastore_1 | [datastore] INFO: Local Datastore initialized: datastore_1 | [datastore] Type: High Replication datastore_1 | [datastore] Storage: /datastore/.data/WEB-INF/appengine-generated/local_db.bin datastore_1 | [datastore] Jan 22, 2020 6:22:02 AM com.google.cloud.datastore.emulator.impl.LocalDatastoreFileStub load datastore_1 | [datastore] INFO: Time to load datastore: 218 ms datastore_1 | [datastore] API endpoint: http://0.0.0.0:8081 datastore_1 | [datastore] If you are using a library that supports the DATASTORE_EMULATOR_HOST environment variable, run: datastore_1 | [datastore] datastore_1 | [datastore] export DATASTORE_EMULATOR_HOST=0.0.0.0:8081 datastore_1 | [datastore] datastore_1 | [datastore] Dev App Server is now running. datastore_1 | [datastore] datastore_1 | [datastore] The previous line was printed for backwards compatibility only. datastore_1 | [datastore] If your tests rely on it to confirm emulator startup, datastore_1 | [datastore] please migrate to the emulator health check endpoint (/). Thank you! datastore_1 | [datastore] The health check endpoint for this emulator instance is http://0.0.0.0:8081/Jan 22, 2020 6:22:11 AM io.gapi.emulators.grpc.GrpcServer$3 operationComplete datastore_1 | [datastore] INFO: Adding handler(s) to newly registered Channel. datastore_1 | [datastore] Jan 22, 2020 6:22:11 AM io.gapi.emulators.netty.HttpVersionRoutingHandler channelRead datastore_1 | [datastore] INFO: Detected HTTP/2 connection.データ投入

エミュレータのエンドポイントに、リクエストを投げてあげれば、ダンプデータも取り込める

docker-compose exec datastore bash ./import/run.sh参考

下記のサイトを参考にさせていただきました。

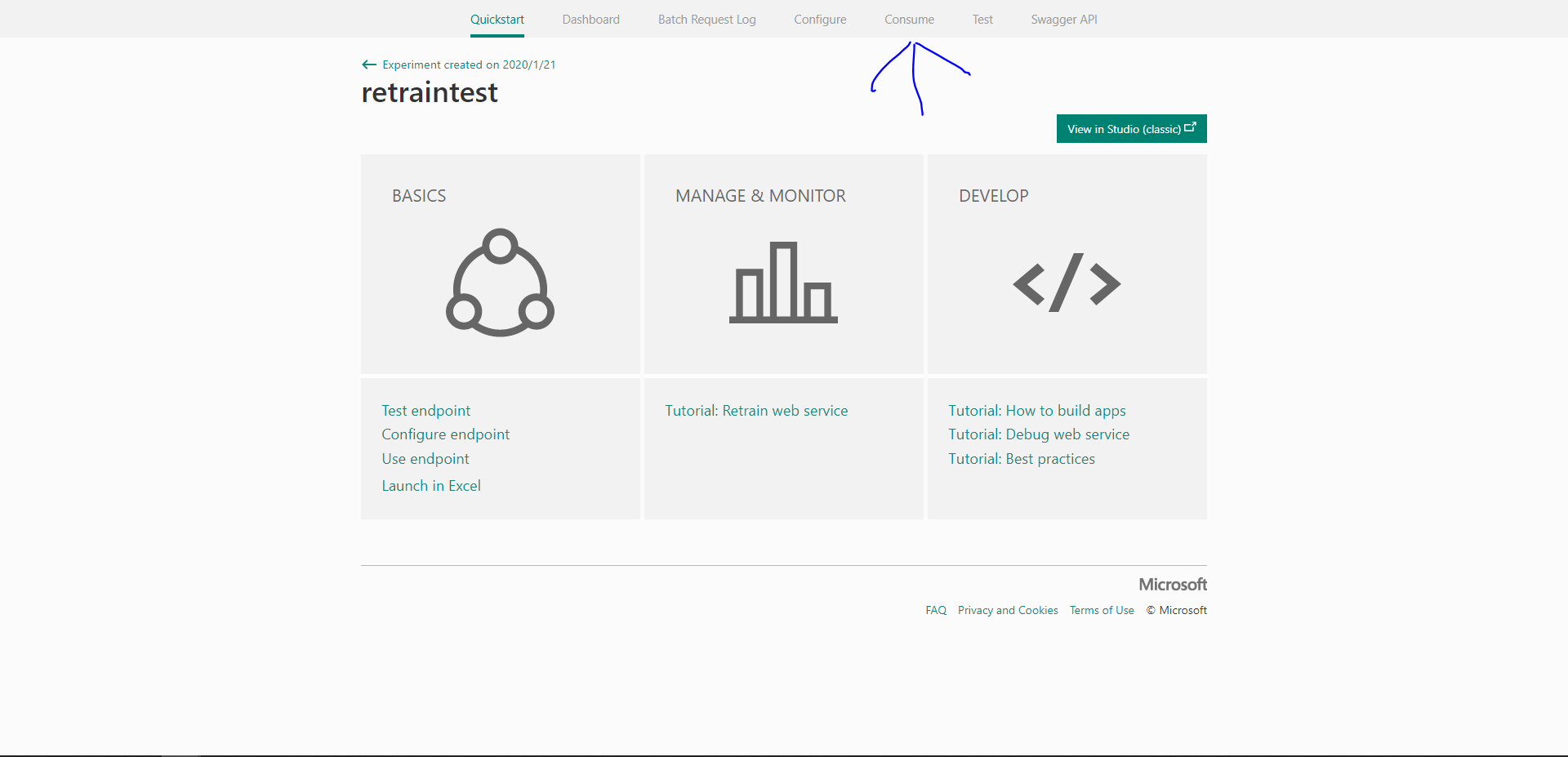

- 投稿日:2020-01-22T23:09:55+09:00

学習記録 その26(30日目)

学習記録(30日目)

勉強開始:12/7(土)〜

教材等:

・大重美幸『詳細! Python3 入門ノート』(ソーテック社、2017年):12/7(土)〜12/19(木)読了

・Progate Python講座(全5コース):12/19(木)〜12/21(土)終了

・Andreas C. Müller、Sarah Guido『(邦題)Pythonではじめる機械学習』(オライリージャパン、2017年):12/21(土)〜12月23日(土)読了

・Kaggle : Real or Not? NLP with Disaster Tweets :12月28日(土)投稿〜1月3日(金)まで調整

・Wes Mckinney『(邦題)Pythonによるデータ分析入門』(オライリージャパン、2018年):1/4(水)〜1/13(月)読了

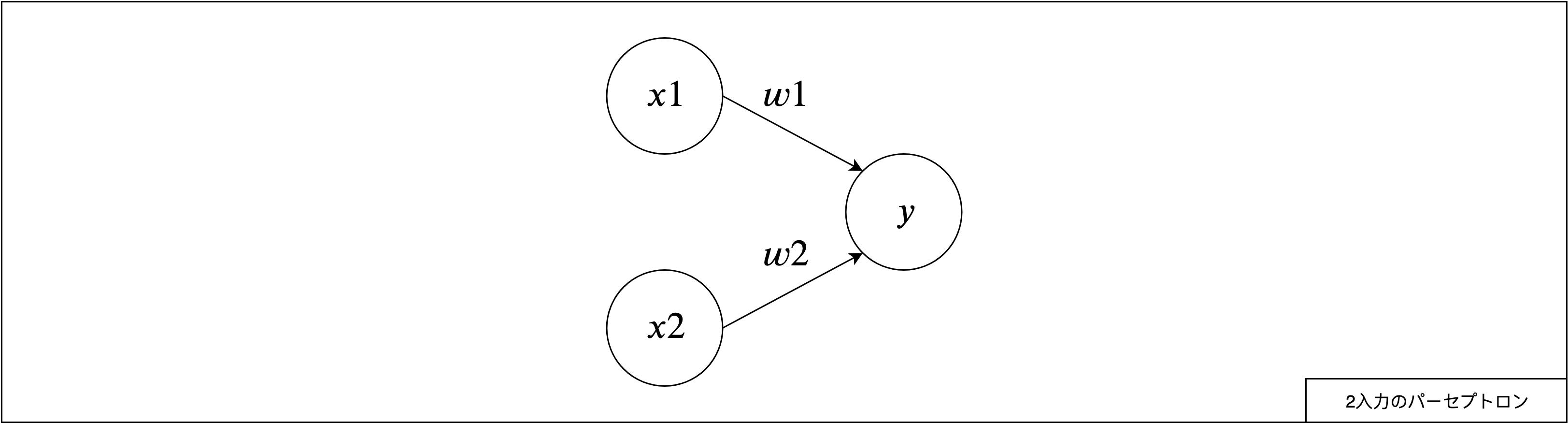

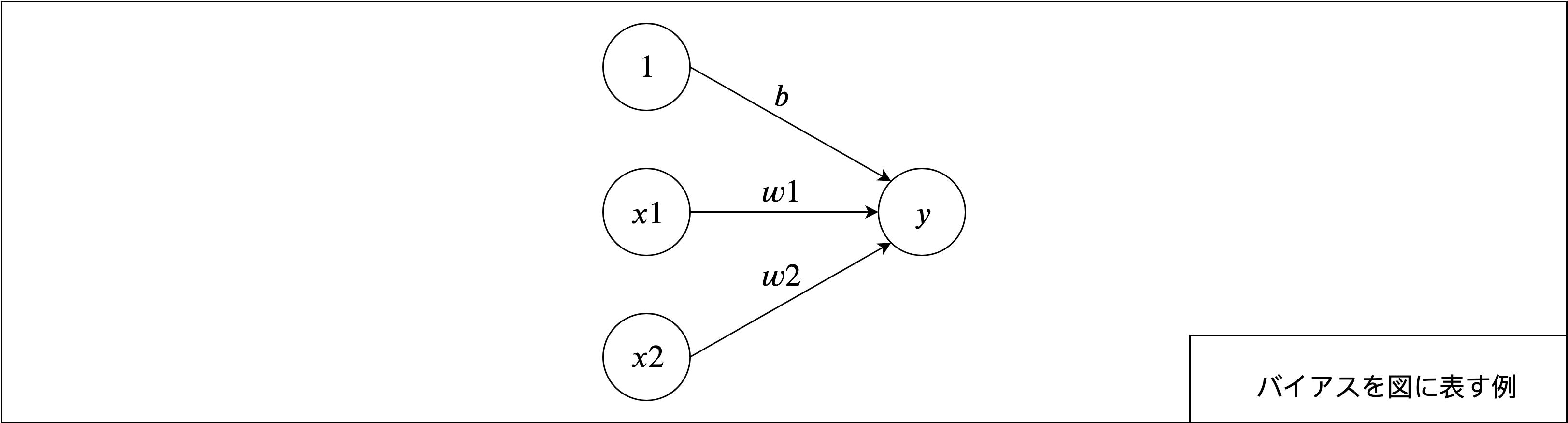

・斎藤康毅『ゼロから作るDeep Learning』(オライリージャパン、2016年):1/15(水)〜1/20(月)

・François Chollet『PythonとKerasによるディープラーニング』(クイープ、2018年):1/21(火)〜『PythonとKerasによるディープラーニング』

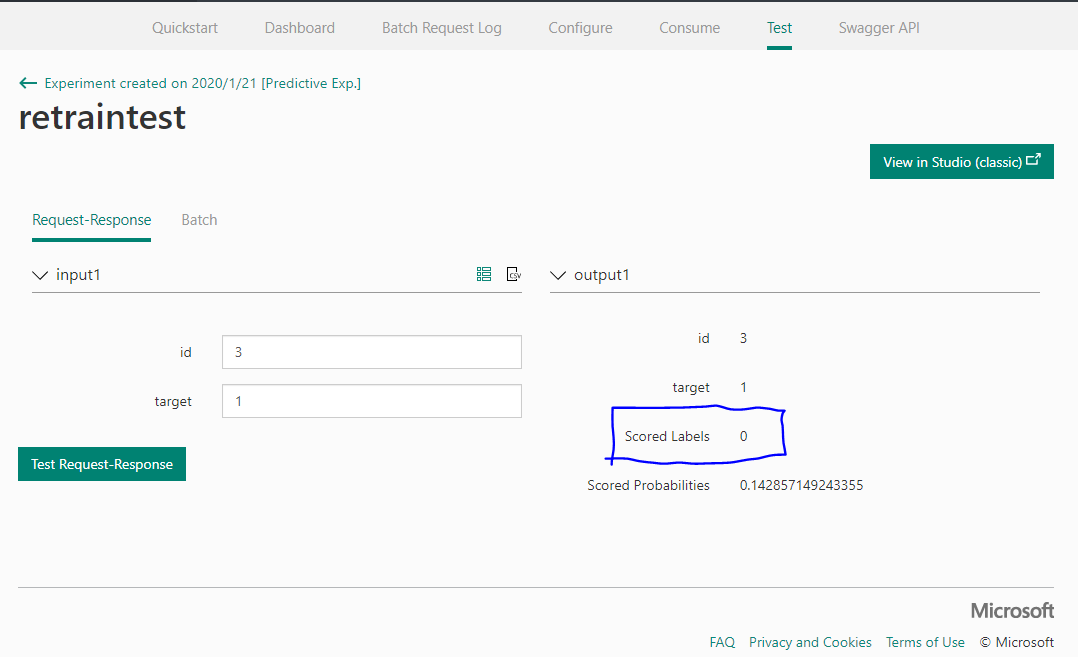

p.94 第3章 ニューラルネットワークまで読み終わり。

kerasによる回帰モデルfrom keras import models from keras import layers def build_model(): #addで層を追加できる。今回は2層で構成 model = models.Sequential() #入力(input_shape)に対し64個のユニットで隠れ層を作成、活性化関数はReLU model.add(layers.Dense(64, activation = 'relu', input_shape=(train_data.shape[1],))) #2層目 model.add(layers.Dense(64, activation = 'relu')) #最終層 スカラー回帰問題であることから活性化関数は適用しない。(数字幅が固定されてしまう。) model.add(layers.Dense(1)) #重み調整のオプティマイザーはrmsprop、損失関数はmse、指標はmae model.compile(optimizer='rmsprop', loss='mse', metrics=['mae']) return model第1層における第3引数input_shapeのshape[1]の後ろのカンマが何を意味しているのかさっぱりわからず、不要と思ってカンマを外したらエラーを吐くわで、色々と探しまわっていたところ以下のような記事を見つけた

What does TensorFlow shape (?,) mean? (stackoverflow)

どうやら、カンマは任意の次元をとるテンソルを取得するために使用するとのこと。

と、ここまでやった後、

train_data.shape[1] = 13 input_shape(13, )であることに気が付いた。

スライシングのような感じで、リスト[]の外にカンマを置く特別な処理なんだろうという意味のわからない勘違いをしてました。行き詰まったら、まずは慌てず構造を読み解いて、一つ一つ細分化し理解するのが大事ですね。

- 投稿日:2020-01-22T22:45:03+09:00

LiquidTap Python Clientを使う①

「Liquid by Quoine」の"Order Book"を取得する

(2020.01.22)

ライブラリをインストールしてBTC/JPYを取得してみる。ライブラリをインストール

$ pip3 install liquidtap本家のサンプルを参考にコードを書く

本家:https://github.com/QuoineFinancial/liquid-tap-python

price.pyimport liquidtap import time def update_callback_buy(data): print("buy:" + data) def update_callback_sell(data): print("sell:" + data) def on_connect(data): tap.pusher.subscribe("price_ladders_cash_btcjpy_buy").bind('updated', update_callback_buy) tap.pusher.subscribe("price_ladders_cash_btcjpy_sell").bind('updated', update_callback_sell) if __name__ == "__main__": tap = liquidtap.Client() tap.pusher.connection.bind('pusher:connection_established', on_connect) tap.pusher.connect() while True: # 無限ループ time.sleep(1)実行

実行してbuyとsellが(何行も)表示されれば成功。

$ python3 price.py sell:[["948886.00000","0.01419278"],["948922.00000","0.02100000"],["948934.00000","0.00191306"],["948944.94000","0.00100000"],["948946.00000","0.03242956"],["948947.00000","0.03242988"],["948954.00000","0.00850000"],["948955.94000","0.03243954"],["948956.94000","0.01621739"],["948959.94000","0.03243965"],["948962.94000","0.02800000"],["948975.00000","0.00100000"],["948987.00000","0.00900000"],["948987.93700","0.03705000"],["948991.65500","0.07000000"],["948996.00000","0.02100000"],["949000.00000","2.00000000"],["949018.00000","0.01000000"],["949046.89124","0.01000000"],["949087.99999","0.06000000"],["949101.61000","0.00100000"],["949103.00000","0.04900000"],["949143.43000","0.25140000"],["949158.06000","1.32366279"],["949183.00000","0.04000000"],["949206.50000","0.01000000"],["949219.97000","0.00100000"],["949249.50000","0.07000000"],["949265.27000","0.01220000"],["949283.00000","0.15000000"],["949307.69000","0.00860000"],["949354.00000","0.38919067"],["949355.00000","0.22500000"],["949357.00000","4.00000000"],["949371.00000","0.01000000"],["949384.00000","0.01100000"],["949390.11000","0.03999999"],["949399.00000","0.04000000"],["949421.11000","0.03999999"],["949427.00000","0.01710000"]] buy:[["948627.00000","0.03242956"],["948626.00000","0.03242988"],["948619.00000","0.04000000"],["948618.50000","0.00200000"],["948611.66000","0.03243954"],["948609.16000","0.03979000"],["948607.66000","0.01621955"],["948604.66000","0.01622010"],["948601.66000","0.00950000"],["948591.65500","0.07000000"],["948556.00000","0.03750000"],["948549.67000","0.01000000"],["948537.00001","0.01621739"],["948522.01000","0.01400000"],["948520.63000","0.00200000"],["948519.00001","0.03000000"],["948472.38000","0.01000000"],["948468.10000","0.10000000"],["948441.00000","0.02610000"],["948437.00000","0.04076885"],["948434.00000","0.00500000"],["948409.18000","0.00200000"],["948409.00000","0.06000000"],["948406.00000","0.03000000"],["948405.00000","0.01000000"],["948393.75000","0.02800000"],["948393.00000","0.02880000"],["948379.00000","0.02520000"],["948371.01000","0.13080000"],["948371.00000","0.03478991"],["948363.57077","0.00852120"],["948350.16098","0.00345380"],["948341.00000","0.50000013"],["948323.98000","0.17633721"],["948287.75000","0.00100000"],["948275.00000","0.09761507"],["948269.00000","0.01989854"],["948239.51000","0.01000000"],["948239.00000","0.20692222"],["948223.00000","0.15000000"]] buy:[["948627.00000","0.03242956"],["948626.00000","0.03242988"],["948619.00000","0.04000000"],["948618.50000","0.00200000"],["948611.66000","0.03243954"],["948609.16000","0.03979000"],["948607.66000","0.01621955"],["948604.66000","0.01622010"],["948601.66000","0.00950000"],["948591.65500","0.07000000"],["948556.00000","0.03750000"],["948549.67000","0.01000000"],["948537.00001","0.01621739"],["948522.01000","0.01400000"],["948520.63000","0.00200000"],["948472.38000","0.01000000"],["948468.10000","0.10000000"],["948441.00000","0.02610000"],["948437.00000","0.04076885"],["948434.00000","0.00500000"],["948409.18000","0.00200000"],["948409.00000","0.06000000"],["948406.00000","0.03000000"],["948405.00000","0.01000000"],["948393.75000","0.02800000"],["948393.00000","0.02880000"],["948379.00000","0.02520000"],["948371.01000","0.13080000"],["948371.00000","0.03478991"],["948363.57077","0.00852120"],["948350.16098","0.00345380"],["948341.00000","0.50000013"],["948323.98000","0.17633721"],["948287.75000","0.00100000"],["948275.00000","0.09761507"],["948269.00000","0.01989854"],["948239.51000","0.01000000"],["948239.00000","0.20692222"],["948223.00000","0.15000000"],["948184.00000","0.22500000"]] buy:[["948627.00000","0.03242956"],["948626.00000","0.03242988"],["948619.00000","0.04000000"],["948618.50000","0.00200000"],["948611.66000","0.03243954"],["948609.16000","0.03979000"],["948607.66000","0.01621955"],["948604.66000","0.01622010"],["948601.66000","0.00950000"],["948591.65500","0.07000000"],["948556.00000","0.03750000"],["948549.67000","0.01000000"],["948537.00001","0.01621739"],["948522.01000","0.01400000"],["948520.63000","0.00200000"],["948488.00001","0.03000000"],["948472.38000","0.01000000"],["948468.10000","0.10000000"],["948441.00000","0.02610000"],["948437.00000","0.04076885"],["948434.00000","0.00500000"],["948409.18000","0.00200000"],["948409.00000","0.06000000"],["948406.00000","0.03000000"],["948405.00000","0.01000000"],["948393.75000","0.02800000"],["948393.00000","0.02880000"],["948379.00000","0.02520000"],["948371.01000","0.13080000"],["948371.00000","0.03478991"],["948363.57077","0.00852120"],["948350.16098","0.00345380"],["948341.00000","0.50000013"],["948323.98000","0.17633721"],["948287.75000","0.00100000"],["948275.00000","0.09761507"],["948269.00000","0.01989854"],["948239.51000","0.01000000"],["948239.00000","0.20692222"],["948223.00000","0.15000000"]] buy:[["948627.00000","0.03242956"],["948626.00000","0.03242988"],["948619.00000","0.04000000"],["948618.50000","0.00200000"],["948611.66000","0.03243954"],["948609.16000","0.03979000"],["948607.66000","0.01621955"],["948604.66000","0.01622010"],["948601.66000","0.00950000"],["948591.65500","0.07000000"],["948556.00000","0.03750000"],["948549.67000","0.01000000"],["948537.00001","0.01621739"],["948522.01000","0.01400000"],["948520.63000","0.00200000"],["948488.00001","0.03000000"],["948472.38000","0.01000000"],["948468.10000","0.10000000"],["948441.00000","0.02610000"],["948434.00000","0.00500000"],["948411.00000","0.04076885"],["948409.18000","0.00200000"],["948409.00000","0.06000000"],["948406.00000","0.03000000"],["948405.00000","0.01000000"],["948393.75000","0.02800000"],["948393.00000","0.02880000"],["948379.00000","0.02520000"],["948371.01000","0.13080000"],["948371.00000","0.03478991"],["948363.57077","0.00852120"],["948350.16098","0.00345380"],["948341.00000","0.50000013"],["948323.98000","0.17633721"],["948287.75000","0.00100000"],["948275.00000","0.09761507"],["948269.00000","0.01989854"],["948239.51000","0.01000000"],["948239.00000","0.20692222"],["948223.00000","0.15000000"]]無限ループなので Ctrl+c で停止。

- 投稿日:2020-01-22T21:12:35+09:00

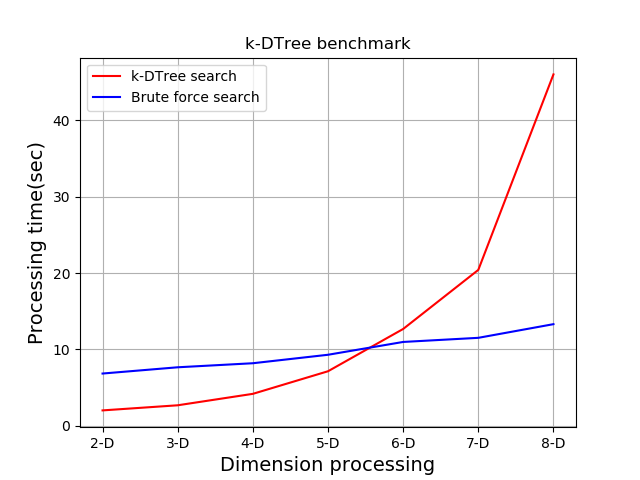

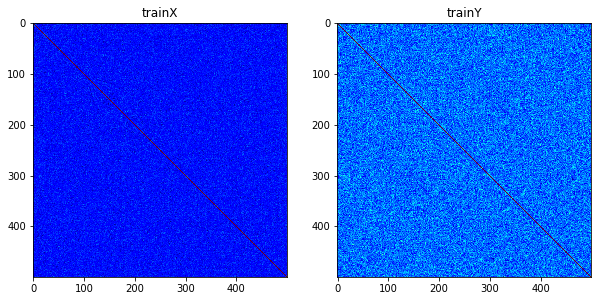

SciPy KDTree vs 総当たりベンチマーク

はじめに

k次元のユークリッド空間に点を空間分割で分類し、k次元領域の

点探索を効率的におこなうのがk-DTreeです。

SciPyにこんなのがあるとは知らなったので、どれくらい効率がいいか?

ベンチマークを行ってみたいと思います。

以降、2次元は2-D, 3次元は3-Dという風にk次元について

k-Dと表記します。比較条件

データ件数 100000件

検索回数 10000回

2-Dから8-Dデータまで行います。

各次元について4回ずつ探索を行います。

leafsizeは10固定。環境

Anaconda

Python 3.7.6

scipy.version.full_version 1.3.2

windows10プログラム

kdtbench.pydef search(S, pt): # 距離を求める distary = ss.distance.cdist([pt], S, metric='euclidean') # 最小のインデックスを求める idx = distary.argmin() return (distary[0, idx], idx) def benchmark(x, s, kdt, no, i): # k-DTree 探索 kdstart = time.time() for search_cond in s: dist, hitindex = kdtree.query(search_cond) kd_elapsed_time = time.time() - kdstart print('%d:%d-D K-DTree(秒) %.2f' % (i, no, kd_elapsed_time)) # 総あたり 探索 brstart = time.time() for search_cond in s: dist, hitindex = search(x, search_cond) br_elapsed_time = time.time() - brstart print('%d:%d-D 総当たり(秒) %.2f' % (i, no, br_elapsed_time)) return kd_elapsed_time, br_elapsed_time count_data = 100000 count_key = 10000 numturns = 4 np.random.seed(0) for n in range(2,9): #2-D...8-D X = np.random.rand(count_data, n) * 1000.0 S = np.random.rand(count_key, n) * 1000.0 kdtree = ss.KDTree(X, leafsize=10) total_k = 0 total_a = 0 for i in range(0,numturns): ktm, atm = benchmark(X,S, kdtree, n, i) total_k += ktm total_a += atm print('Avg k-DTree:%.2f秒 総当たり:%.2f秒' % (total_k/numturns, total_a/numturns)) print()ベンチマーク実施

プログラムを実行。

$ python kdtbench.py 0:2-D K-DTree(秒) 2.00 0:2-D 総当たり(秒) 6.61 1:2-D K-DTree(秒) 1.99 1:2-D 総当たり(秒) 6.62 2:2-D K-DTree(秒) 2.02 2:2-D 総当たり(秒) 6.78 3:2-D K-DTree(秒) 2.01 3:2-D 総当たり(秒) 7.33 Avg KDTree:2.00秒 総当たり:6.83秒 0:3-D K-DTree(秒) 2.71 0:3-D 総当たり(秒) 7.81 ~~~ 省略 ~~~ベンチマーク結果

条件ごとの測定結果の平均時間(秒)が下記です。

総当たり(秒) K-DTree(秒) 2-D 6.83 2.00 3-D 7.65 2.67 4-D 8.18 4.17 5-D 9.29 7.13 6-D 10.97 12.67 7-D 11.51 20.41 8-D 13.30 46.03 各PC事に性能が異なるため時間うんぬんは意味が無く、比較で見て下さい。

K-DTree searchがK-DTreeによる探索処理の結果を示し、

Brute force searchが総当たり探索処理の結果です。5-D以降、性能が逆転することがわかりましたが、ここまで使うかは

今のところ分かりません。自分の場合は使ってもせいぜい3-Dくらいまで、

たぶんpythonではこういう使い方はしないかな。

ご清聴ありがとうございました。参考

- 投稿日:2020-01-22T20:24:15+09:00

MacOS Catalina(10.15.2) で、旧OSからアップデートした環境でpython pipがOpenSSLのエラーになる問題の解決法

TL;DR

/Library/Developer/CommandLineToolsをCommandLineTools.bakとかにmvして、xcode-select --installする。なぜそうするのか

Catalinaにupgradeする前から入れてあったCommandLineToolsがどうも古いのに新しいものと誤認識されているらしい。

なのでxcode-select --installしてもalready installedって言われてしまう。

それを強制的に入れ直すため。いろいろ修正方法が書いてあるけどどれも関係なかった

以下は無関係だった。

- brewを入れ直す

- OpenSSLをbrewで入れ直す

- MacOS10.14.pkgを入れる → そもそもファイルが無いのでできない。

問題のエラー文字列

$ pip install --upgrade pip pip is configured with locations that require TLS/SSL, however the ssl module in Python is not available. Retrying (Retry(total=4, connect=None, read=None, redirect=None, status=None)) after connection broken by 'SSLError("Can't connect to HTTPS URL because the SSL module is not avai lable.")': /simple/pip/ Retrying (Retry(total=3, connect=None, read=None, redirect=None, status=None)) after connection broken by 'SSLError("Can't connect to HTTPS URL because the SSL module is not avai lable.")': /simple/pip/ Retrying (Retry(total=2, connect=None, read=None, redirect=None, status=None)) after connection broken by 'SSLError("Can't connect to HTTPS URL because the SSL module is not avai lable.")': /simple/pip/ Retrying (Retry(total=1, connect=None, read=None, redirect=None, status=None)) after connection broken by 'SSLError("Can't connect to HTTPS URL because the SSL module is not avai lable.")': /simple/pip/ Retrying (Retry(total=0, connect=None, read=None, redirect=None, status=None)) after connection broken by 'SSLError("Can't connect to HTTPS URL because the SSL module is not avai lable.")': /simple/pip/ Could not fetch URL https://pypi.org/simple/pip/: There was a problem confirming the ssl certificate: HTTPSConnectionPool(host='pypi.org', port=443): Max retries exceeded with ur l: /simple/pip/ (Caused by SSLError("Can't connect to HTTPS URL because the SSL module is not available.")) - skipping Requirement already up-to-date: pip in /usr/local/lib/python3.7/site-packages (18.1) pip is configured with locations that require TLS/SSL, however the ssl module in Python is not available. Could not fetch URL https://pypi.org/simple/pip/: There was a problem confirming the ssl certificate: HTTPSConnectionPool(host='pypi.org', port=443): Max retries exceeded with ur l: /simple/pip/ (Caused by SSLError("Can't connect to HTTPS URL because the SSL module is not available.")) - skippingbrewが悪いのか、MacOSが悪いのか…。

もうCloud Shell(GCP)上でやったほうが楽そう。泣ける。

- 投稿日:2020-01-22T20:06:47+09:00

ビジネスで欠損値を扱うときの注意点(システム、機械学習予測モデル)

欠損値の意味合いは色々ある

このタイトルを見ると、「機械学習 欠損値」で検索すると出てきそうな、欠損値の補完の仕方をイメージすると思いますが、情報がありふれているため、ここでは言及しません。ここで言及したいのは、機械学習の予測モデルに入れるデータの欠損値をどう処理するかというテクニカルなことではなく、データが欠損している意味合いが異なる場合に機械学習モデル自身を見直す、モデルを使ったビジネス上の運用も慎重に考える必要があるということです。

欠損と未知は違う

いわゆる欠損値の種類といったときに、MCAR, MAR, MNARがありますが、これはデータを取得しようと試みた結果様々な理由でデータが欠損しているときの欠損の仕方の違いです。これには「データを取得しようとした」という前提があり、データを選択するバイアスになっています。一方そもそもデータの取得の試み自体まだ行っていない場合はデータを取得しようとした結果の「欠損」ではなく、「未知」なのです。

「欠損」と「未知」がなぜ重要か

ここまで見ると、当たり前じゃないかと思うでしょう。ただ、データ分析したり、データに関連した意思決定をしたり際に往々にしてデータベースやシステムから出力されたデータを使いますが、意識して「欠損」と「未知」を区別しない限り、データの持ち方上欠損値になってしまっていることが大いにあります。

例えば、ECサイトの会員ごとに再購買するか否かを予測する2値分類のタスクを行う予測モデルを作って、レコメンドに活用したいとします。そして、直近あるアンケートを順次会員に対して実施しており、週ごとに会員群を決めてアンケートを配信し、回答を得ます。アンケートの回答内容は各会員の嗜好や行動属性に関する情報があり、レコメンドのモデルを作成する人はその情報を活用してモデルの精度改善に生かそうとします。この時に、データベース上のアンケート結果が欠損ないし未知の違いを意識して設計されず、それを知らずにアンケート結果を用いて予測モデルを作成すると、おおいに実運用時で精度が悪化する可能性が高いです。

なぜなら、アンケートを取った会員群でアンケート結果が欠損している場合、そこには会員の何かしらの意図があり、回答しない結果欠損となっている一方、アンケートをまだ配信していない会員群のデータは、意図がなく単純に未知なので、これを欠損と同じように扱うと予測を誤るからです。ECサイトに愛着があって利用する会員ならアンケートを丁寧に回答して、欠損値は少ないので、欠損値があると再購買しない方向に機械学習モデルは学習するでしょう。一方このモデルを、単純にアンケートに未回答ゆえに未知な会員に適用すると、本来アンケートが配信されていれば丁寧に回答するリピーターも欠損値の影響で予測モデルで再購買しないと判定されてしまうのです。

どう対処すべきか

以上を踏まえて、欠損と未知の違いを意識しつつ、要件に応じて対応を変える必要があります。

欠損と未知が混在した情報でもビジネスに活用したい

このような場合は、下記のような対応が考えられるでしょう。

- システム設計時に、データが未知である事と、欠損している事を明示的に分けて定義する

- システム側で対応が困難な時には、データの前処理で欠損と未知の違いを欠損値補完の方法を変える、ないし欠損している予測対象群と未知である予測対象群で分けて予測モデルを作成し運用に使う

上記以外のプラスアルファで情報を生かしたい場合

特に、無理して欠損と未知が混在した情報を使用する必然性がなければ、以下のようにすればよいでしょう。

- そもそも情報として使わない

- 欠損と未知の違いがなくなるまで待つ(前述の例でいえば、全会員のアンケート取得が終わるまで待つ)

実際に検証してみた

(工事中)

まとめ

ここまで、実際にモデルも作って、「欠損」と「未知」が混在した状況があった時に、全て一様に欠損値として扱った予測モデルを適用するリスクと取りうる対応案を提示しました。言われれば当たり前ですが、概念としての違いがデータベースの設計時には思い及ばなかったり、データとしてだけ渡された場合に、大いに誤るリスクをはらんでいるため、記事にしました。また、機械学習モデルのみならず、データに欠損が関連し、それによるビジネス判断が必要な場合でも参考になる考え方ではないかと思います。

ご意見、フィードバック等あればぜひお願いいたします。

- 投稿日:2020-01-22T19:29:16+09:00

Flask + LINE Messaging APIでの人工知能LINEボットの作り方

Flask + LINE Messaging APIでの人工知能LINEボットの作り方

ナカノヒトシさんの書籍

Python + LINEで作る人工知能開発入門 - Flask + LINE Messaging APIでの人工知能LINEボットの作り方まあまあ面白かった。

この手のアプリはたくさんあるがLINEボットにすると使う方はラクかも。本の最後に宿題を出され、回答はないです自力でがんばりましょうと厳しいナカノさん。

少し苦労して宿題したので参考までに。

#app.py # ユーザの送った画像をGoogle Vison APIで顔検出しcat.pngで隠した合成写真をリプライ(顔複数対応) import io import base64 import json import requests from flask import Flask, request, abort from PIL import Image #Pillowをインストール pip3 install pillow from linebot import ( LineBotApi, WebhookHandler ) from linebot.exceptions import ( InvalidSignatureError ) from linebot.models import ( MessageEvent, TextMessage, TextSendMessage, ImageMessage, ImageSendMessage ) import os # LINEアクセストークンとアプリケーションシークレット ACCESS_TOKEN = '' SECRET = '' # Google Vision APIキー API_KEY = '' app = Flask(__name__) line_bot_api = LineBotApi(ACCESS_TOKEN) handler = WebhookHandler(SECRET) @app.route('/') def hello_world(): return 'Hello World!' @app.route('/callback',methods=['POST']) def callback(): signature = request.headers['X-Line-Signature'] body = request.get_data(as_text=True) app.logger.info("Request body: " + body) try: handler.handle(body, signature) except InvalidSignatureError: print("Invalid signature. Please check your channel access token/channel secret.") abort(400) return 'OK' @handler.add(MessageEvent,message=ImageMessage) def handle_message(event): message_content = line_bot_api.get_message_content(event.message.id) # event.message.idを指定することで画像本体データを読み出せる # message_content.content #取得した画像ファイル本体 image_base64 = base64.b64encode(message_content.content) #画像ファイルをbase64に変換 #リクエストボディを作成(json.dumps()でJSONに変換してる) req_body = json.dumps({ 'requests': [{ 'image': { 'content': image_base64.decode('utf-8') }, 'features': [{ 'type': 'FACE_DETECTION', 'maxResults': 20, }] }] }) # Vison APIのエンドポイント↓ res = requests.post("https://vision.googleapis.com/v1/images:annotate?key=" + API_KEY, data=req_body) #print('res内容は、' + res.text) result = res.json() vertices = result["responses"][0]["faceAnnotations"] #print('vertices内容は、' + json.dumps(vertices)) ## response内容は、レスポンス.jsonを参照. if vertices: print('取得できた') image_base = Image.open(io.BytesIO(message_content.content)) for face in vertices: corner = face["boundingPoly"]['vertices'][0] print('cornerは、' + json.dumps(corner)) print('face["boundingPoly"]["vertices"][1]["x"]は、' + json.dumps(face["boundingPoly"]['vertices'][1]["x"])) width = face["boundingPoly"]['vertices'][1]["x"] - face["boundingPoly"]['vertices'][0]["x"] height = face["boundingPoly"]['vertices'][2]["y"] - face["boundingPoly"]['vertices'][1]["y"] image_cover = Image.open('static/cat.png') # cat.pngはアルファチャンネル画像でないとダメ。ValueError: bad transparency maskエラー image_cover = image_cover.resize((width,height)) image_base.paste(image_cover, (corner['x'],corner['y']), image_cover) # Image.paste(im, box=None, mask=None) print('forループおわり') image_base.save('static/' + event.message.id + '.jpg') else: print('取得できない') line_bot_api.reply_message( event.reply_token, ImageSendMessage( original_content_url = "https://hidden-savannah-xxxxx.herokuapp.com/static/" + event.message.id + ".jpg", preview_image_url = "https://hidden-savannah-xxxxx.herokuapp.com/static/" + event.message.id + ".jpg" ) ) if __name__ == "__main__": app.run(host="0.0.0.0", port=int(os.environ.get("PORT", 5000)))

- 念の為、78行目の

print('vertices内容は、' + json.dumps(vertices))のレスポンス内容[ { "boundingPoly": { "vertices": [ { "x": 917, "y": 318 }, { "x": 1174, "y": 318 }, { "x": 1174, "y": 616 }, { "x": 917, "y": 616 } ] }, "fdBoundingPoly": { "vertices": [ { "x": 971, "y": 396 }, { "x": 1163, "y": 396 }, { "x": 1163, "y": 588 }, { "x": 971, "y": 588 } ] }, "landmarks": [ { "type": "LEFT_EYE", "position": { "x": 1031.1968, "y": 456.0161, "z": 0.0003030986 } }, { "type": "RIGHT_EYE", "position": { "x": 1112.0862, "y": 460.92987, "z": 28.232975 } }, { "type": "LEFT_OF_LEFT_EYEBROW", "position": { "x": 1008.84607, "y": 436.544, "z": -1.8571037 } }, { "type": "RIGHT_OF_LEFT_EYEBROW", "position": { "x": 1060.1007, "y": 440.86813, "z": -7.585352 } }, { "type": "LEFT_OF_RIGHT_EYEBROW", "position": { "x": 1095.2485, "y": 442.76245, "z": 5.0468025 } }, { "type": "RIGHT_OF_RIGHT_EYEBROW", "position": { "x": 1131.141, "y": 444.30832, "z": 41.595203 } }, { "type": "MIDPOINT_BETWEEN_EYES", "position": { "x": 1075.8728, "y": 455.9283, "z": -1.5975293 } }, { "type": "NOSE_TIP", "position": { "x": 1080.8457, "y": 504.33997, "z": -20.247692 } }, { "type": "UPPER_LIP", "position": { "x": 1071.2343, "y": 531.5437, "z": -1.6211907 } }, { "type": "LOWER_LIP", "position": { "x": 1069.6505, "y": 551.9242, "z": 4.4038887 } }, { "type": "MOUTH_LEFT", "position": { "x": 1035.7985, "y": 538.815, "z": 8.222528 } }, { "type": "MOUTH_RIGHT", "position": { "x": 1101.0676, "y": 541.8905, "z": 30.981604 } }, { "type": "MOUTH_CENTER", "position": { "x": 1070.1655, "y": 541.40643, "z": 4.1978736 } }, { "type": "NOSE_BOTTOM_RIGHT", "position": { "x": 1092.8889, "y": 510.94235, "z": 16.238985 } }, { "type": "NOSE_BOTTOM_LEFT", "position": { "x": 1049.6199, "y": 507.50146, "z": 0.9902145 } }, { "type": "NOSE_BOTTOM_CENTER", "position": { "x": 1072.0765, "y": 515.82806, "z": -2.7877321 } }, { "type": "LEFT_EYE_TOP_BOUNDARY", "position": { "x": 1037.2472, "y": 452.2355, "z": -4.3320293 } }, { "type": "LEFT_EYE_RIGHT_CORNER", "position": { "x": 1047.4124, "y": 459.2465, "z": 6.317641 } }, { "type": "LEFT_EYE_BOTTOM_BOUNDARY", "position": { "x": 1030.3141, "y": 461.9699, "z": 0.34013578 } }, { "type": "LEFT_EYE_LEFT_CORNER", "position": { "x": 1018.07513, "y": 455.93164, "z": 2.3924496 } }, { "type": "LEFT_EYE_PUPIL", "position": { "x": 1034.6456, "y": 457.22366, "z": -1.4217875 } }, { "type": "RIGHT_EYE_TOP_BOUNDARY", "position": { "x": 1109.9236, "y": 456.6617, "z": 21.767094 } }, { "type": "RIGHT_EYE_RIGHT_CORNER", "position": { "x": 1119.8134, "y": 462.12448, "z": 38.996845 } }, { "type": "RIGHT_EYE_BOTTOM_BOUNDARY", "position": { "x": 1110.3936, "y": 466.81308, "z": 26.98832 } }, { "type": "RIGHT_EYE_LEFT_CORNER", "position": { "x": 1094.9646, "y": 462.28857, "z": 22.470396 } }, { "type": "RIGHT_EYE_PUPIL", "position": { "x": 1109.2263, "y": 461.79114, "z": 25.238665 } }, { "type": "LEFT_EYEBROW_UPPER_MIDPOINT", "position": { "x": 1037.4519, "y": 429.95596, "z": -10.386488 } }, { "type": "RIGHT_EYEBROW_UPPER_MIDPOINT", "position": { "x": 1116.0272, "y": 434.71762, "z": 18.003847 } }, { "type": "LEFT_EAR_TRAGION", "position": { "x": 954.1669, "y": 484.3548, "z": 76.21559 } }, { "type": "RIGHT_EAR_TRAGION", "position": { "x": 1119.6852, "y": 494.08078, "z": 135.9113 } }, { "type": "FOREHEAD_GLABELLA", "position": { "x": 1078.9543, "y": 441.30212, "z": -4.084726 } }, { "type": "CHIN_GNATHION", "position": { "x": 1062.5234, "y": 589.9864, "z": 16.94458 } }, { "type": "CHIN_LEFT_GONION", "position": { "x": 968.6994, "y": 536.28186, "z": 52.295383 } }, { "type": "CHIN_RIGHT_GONION", "position": { "x": 1117.5015, "y": 545.4246, "z": 105.74548 } } ], "rollAngle": 4.5907497, "panAngle": 19.758451, "tiltAngle": -3.1237326, "detectionConfidence": 0.91960925, "landmarkingConfidence": 0.5607769, "joyLikelihood": "VERY_UNLIKELY", "sorrowLikelihood": "VERY_UNLIKELY", "angerLikelihood": "VERY_UNLIKELY", "surpriseLikelihood": "VERY_UNLIKELY", "underExposedLikelihood": "VERY_UNLIKELY", "blurredLikelihood": "VERY_UNLIKELY", "headwearLikelihood": "LIKELY" }, ・・・・・・・・・・以上でひとり分・・・・・・・・・・・・ ]

書籍の中でうまく行かなかったところは以下の通り。

Flaskアプリをherokuにデプロイ(苦苦々)

- 投稿日:2020-01-22T19:24:22+09:00

自動でVtuberの配信予定を更新するカレンダーを作ってみた

はじめに

はじめまして。ほどよくエンジニアをがんばっているシュンといいます。

自動でVtuberの配信予定を更新するカレンダーを作ってみたので、その過程を書きたいと思います。

今回はYouTube Data APIを使ってYouTubeチャンネルの動画情報を取得します。環境

- Azure VM (Windows Server 2016)

- Python 3.7

用意するデータ

- YouTube チャンネルID

取得するデータ

- チャンネル情報

- 動画情報

方法

まずはじめに、YouTube Data APIを利用できるようにGoogleにアプリケーションを登録します。

詳しい方法はこちら。

(ちなみに、このページからAPIを試すこともできます。)

ここで手に入れたAPIキーを利用して、動画情報を取得していきます。取得の流れとしてはこんな感じになります。

- チャンネルIDからそのチャンネルの動画IDを取得

- 動画IDから動画情報を取得

1. チャンネルIDからそのチャンネルの動画IDを取得

チャンネルIDは知りたいチャンネルのホームを開いたときのURLから取得できます。

例えば僕のイチオシの湊あくあちゃんの場合は、

https://www.youtube.com/channel/UC1opHUrw8rvnsadT-iGp7Cg

これがYouTubeチャンネルのURLなので、チャンネルIDはUC1opHUrw8rvnsadT-iGp7Cgになります。このチャンネルIDを使って動画のリストを取得します。

import urllib.request import json import ssl context = ssl.SSLContext(ssl.PROTOCOL_TLSv1) def get_video_info(channel_id, page_token=None, published_after=None): url = 'https://www.googleapis.com/youtube/v3/search' params = { 'key': 'YOUTUBE_API_KEY', 'part': 'id', 'channelId': channel_id, 'maxResults': 50, 'order': 'date' } if page_token is not None: params['pageToken'] = page_token if published_after is not None: params['publishedAfter'] = published_after req = urllib.request.Request('{}?{}'.format(url, urllib.parse.urlencode(params))) with urllib.request.urlopen(req, context=context) as res: body = json.load(res) return bodyチャンネルID以外にもパラメータとして以下の値を指定します。

- key

- 最初に取得したAPIキー。

- part

- idとsnippetが指定できます。今回は動画IDが分かればいいのでidを指定。

- channelId

- チャンネルID。

- maxResults

- 返ってくるアイテムの最大数。最大で50なので50を指定。

- order

- いろいろ設定できます。日時順で欲しいのでdateを指定。

- pageToken

- 一度で指定した条件に当てはまる動画を取得しきれない場合、nextPageTokenとして次のページを示す値が得られるのでそれを指定することで続きを取得。

- publishedAfter

- 日時を指定して、その日時より後に作成された動画を取得。

- 日時形式例: 2020-01-01T00:00:00Z

2. 動画IDから動画情報を取得

取得した動画IDを使って今度は各動画の詳細情報を取得します。

def get_video_details(video_ids): url = 'https://www.googleapis.com/youtube/v3/videos' params = { 'key': 'YOUTUBE_API_KEY', 'part': 'snippet, liveStreamingDetails', 'id': video_ids } req = urllib.request.Request('{}?{}'.format(url, urllib.parse.urlencode(params))) with urllib.request.urlopen(req, context=context) as res: body = json.load(res) return bodyパラメータは新たにidとして動画IDを指定しているほか、partにsnippetとliveStreamingDetailsを指定しています。

これで動画の基本的な情報に加えてライブ配信時の情報も取得できます。def get_videos(items): video_ids = '' for item in items: if 'videoId' in item['id']: video_ids += item['id']['videoId'] video_ids += ', ' video_details = get_video_details(video_ids[:-2]) for video_detail in video_details['items']: print(video_detail)最初に取得した動画IDのリストの中には再生リストのIDも含まれているので、videoIdを持っているものだけを集めてから動画情報を取得しています。

これらを合わせて実行するコードが↓になります。

video_info = get_video_info(channel_id='CHANNEL_ID', published_after='DATETIME') get_videos(video_info['items']) while 'nextPageToken' in video_info: page_token = video_info['nextPageToken'] video_info = get_video_info(channel_id='CHANNEL_ID', page_token=page_token) get_videos(video_info['items'])最初に日時を指定して取得、その後はnextPageTokenがある限り、取得を続けます。

湊あくあチャンネルの場合、チャンネル設立が2018/7/31なので、これより古い日時で取得を始めれば全動画の情報を取得できます。実際はこのあとカレンダーの更新等を続けて行いますが、それはまたの機会に......。

- 投稿日:2020-01-22T19:02:14+09:00

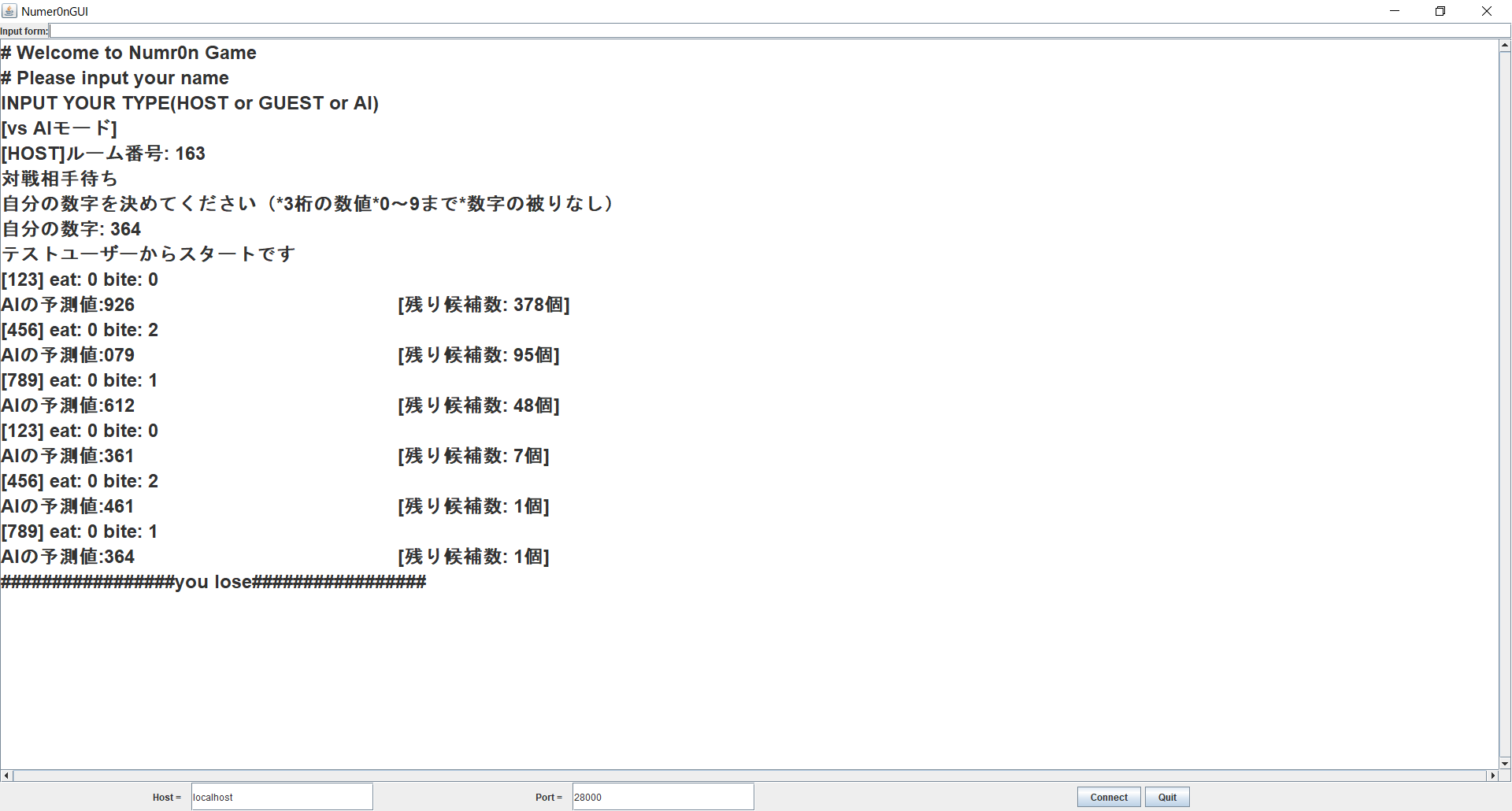

JavaでNumer0nの対戦ゲームを作ってみた(AIも作ったよ)

JavaでNumer0nの対戦ゲームを作ってみた

はじめに

今回、大学の授業でJavaでサーバ・クライアント間の通信を介した何かを作るという課題が出たので、高校生の頃、授業中によくやっていたNumer0nのゲームを作ってみようと思った。

高校生の頃、Numer0nのゲームにはまりすぎて、1手目で〇EAT〇BITEになる確率を手計算で求めて楽しんでた気がする...この記事を読んでくださっている方は、Numer0nの基本的なルールは知っていると思うのでそこのところは割愛させていただきます。

ヌメロンWikipedia開発環境

Java:version 7

Eclipse: Juno 4.2

OS: windows10開発方針

今回のシステムで実装したいことは、

1. サーバ・クライアント間の通信を行い、複数のクライアントが同時にアクセスでき、ルームを作成し、対戦ができる

2. それなりに強いコンピュータ対戦もできるようにする(アルゴリズムの実装)

3. 入力ミスや数値の重複などに対応する

4. ターン制のゲームなので入力を交互に受け取るようにするコード

コードをすべて載せると長くなってしまうので、今回はサーバ側の送受信を担当するChannelクラスと、コンピュータのアルゴリズムを実装したNumer0nAIクラスのみ掲載します。すべてのクラスと発表資料(パワポ)はGitHubに載せてあるのでよかったら見ていってください!pythonのほうでもNumeronAIを実装しているのでpythonよく使う人はそちらもどうぞ!

Javaで作るNumer0n(GitHub)

pythonのNumer0nAI(GitHub)Channelクラスについて

クライアントからの入力を確認するとサーバがChannelを生成し、Channelとクライアントがやり取りをします。そのおかげでクライアントに意図しない例外が発生しても、おおもとのサーバはダウンしないので他のクライアントの接続は保たれます。

Channel.javapackage server; import java.io.BufferedReader; import java.io.IOException; import java.io.InputStreamReader; import java.io.OutputStreamWriter; import java.net.Socket; import java.util.ArrayList; import java.util.List; import java.util.Random; public class Channel extends Thread { JUDGE judge = new JUDGE(); Server server; Socket socket = null; BufferedReader input; OutputStreamWriter output; String handle; String playertype; String roomnumber; String mynumber; String tekinumber; boolean turn; String ex = "926";//AIの最初の予測値 String ca ="0123456789";//candidate number 最初は0~9まで String ex_number; List<String> old_list = new ArrayList<>(); final char controlChar = (char)05; final char separateChar = (char)06; Channel(Socket s,Server cs){ this.server = cs; this.socket = s; this.start(); } synchronized void write(String s){ try{ output.write(s + "\r\n"); output.flush(); }catch(IOException e){ System.out.println("Write Err"); close(); } } public void run(){ List<String> s_list = new ArrayList<>();//クライアントからの入力を受け取り、ためておくリスト String s; String opponent = null; try{ input = new BufferedReader( new InputStreamReader(socket.getInputStream())); output = new OutputStreamWriter(socket.getOutputStream()); write("# Welcome to Numr0n Game"); write("# Please input your name"); handle = input.readLine(); System.out.println("new user: "+ handle); while(true){//HOST or GUEST入力待ち write("INPUT YOUR TYPE(HOST or GUEST or AI)"); playertype = input.readLine(); if(playertype.equals("HOST")){ Random rnd = new Random(); s = String.valueOf(rnd.nextInt(100)+100); write("[HOST]ルーム番号: "+s); break; }else if(playertype.equals("GUEST")){ write("[GUEST]ルーム番号を入力してください"); s = input.readLine(); write("[GUEST]ルーム番号: "+s); break; }else if(playertype.equals("AI")){ write("[vs AIモード]"); Random rnd = new Random(); s = String.valueOf(rnd.nextInt(100)+100); write("[HOST]ルーム番号: "+s); break; }else{ write("ルーム番号入力でエラー"); } } roomnumber = s; //roomnumberの決定 System.out.println(roomnumber); write("対戦相手待ち"); if(playertype.equals("AI")){ //AIとの対戦 write("自分の数字を決めてください(*3桁の数値*0~9まで*数字の被りなし)"); boolean firstnum = false; while(firstnum == false){//最初の自分の数字が上記の条件を満たしているか mynumber = input.readLine(); firstnum = judge.isNumber(mynumber); } write("自分の数字: "+ mynumber); write(handle + "からスタートです"); tekinumber="864"; NumeronAI numeron = new NumeronAI(); while(true){ //ゲームスタート boolean finish = false; s = input.readLine(); if(s == null){ close(); }else{ System.out.println(s); boolean numsuccess = judge.isNumber(s);//数字が定義内 if (numsuccess) { JUDGE eatbite = judge.EatBite(s, tekinumber); finish = judge.Finish(eatbite.eat);//3eatになったかどうか write("["+ s +"] eat: " +String.valueOf(eatbite.eat) +" bite: "+ String.valueOf(eatbite.bite)); //ここからAIのターン JUDGE AIeatbite = judge.EatBite(ex, mynumber); NumeronAI squeeze = numeron.Squeeze(AIeatbite.eat,AIeatbite.bite,ex,ca,old_list); if(squeeze.new_can_list.size()<300){ //System.out.println(Arrays.toString(squeeze.new_can_list.toArray())); //System.out.println(squeeze.can_num); ex_number = numeron.choice(squeeze.new_can_list,squeeze.can_num); }else{ Random rnd = new Random(); int index = rnd.nextInt(100); ex_number = squeeze.new_can_list.get(index); } old_list = new ArrayList<>(squeeze.new_can_list); //System.out.println("残り候補数: " + String.valueOf(old_list.size())); write("AIの予測値:" + ex + " [残り候補数: " + String.valueOf(old_list.size())+"個]"); //System.out.println("AIの予測値: "+ ex); if(mynumber.equals(ex)){ write("#################you lose#################"); } ex = ex_number; //ここまでがAIのターン } else { write(" did not send such a number"); } } if(finish){ write("#################you win#################"); } } }else{//vs人間 while(opponent == null){//対戦相手待ち opponent = server.findopponent(handle,roomnumber); } //write("対戦相手が決まりました"); write("自分の数字を決めてください(*3桁の数値*0~9まで*数字の被りなし)"); boolean firstnum = false; while(firstnum == false){//最初の自分の数字が上記の条件を満たしているか mynumber = input.readLine(); firstnum = judge.isNumber(mynumber); } write("自分の数字: "+ mynumber); while(tekinumber == null){//敵の数値を取得するまで待つ tekinumber = server.findopponentnumber(handle, roomnumber); } if(playertype.equals("HOST")){ turn = true; }else{ turn =false; } write("HOSTプレイヤーからスタートです"); while(true){ //ゲームスタート boolean finish = false; while(true){ //ターンの確認 s_list.add(input.readLine());//入力を入れておく turn = server.isTurn(handle);//turnの確認 if(turn == true){ break; } } s = s_list.get(s_list.size()-1); s_list.clear(); if(s == null){ close(); }else{ System.out.println(s); boolean numsuccess = judge.isNumber(s);//数字が定義内 if (numsuccess) { //write("judge ok"); boolean connectsuccess = server.singleSend(opponent,"[相手の予測] "+s);//相手がいる if(connectsuccess){ //write("相手が存在する"); JUDGE eatbite = judge.EatBite(s, tekinumber); finish = judge.Finish(eatbite.eat);//3eatになったかどうか write(" [自分の予測]"+ s +" eat: " +String.valueOf(eatbite.eat) +" bite: "+ String.valueOf(eatbite.bite)); server.ChangeTurn(handle, opponent);//ターンの切り替え }else{ write("did not find opponent"); } } else { write(" did not send such a number"); } } if(finish){ write("#################you win#################"); server.singleSend(opponent, "#################you lose#################"); } } } }catch(IOException e){ System.out.println("Exception occurs in Channel: "+handle); } } public void close(){ try{ input.close(); output.close(); socket.close(); socket = null; //server.broadcast("回線切断 : " + handle); }catch(IOException e){ System.out.println("Close Err"); } } }NumeronAIクラスについて

NumeronAIクラスはコンピュータの予測部分を実装したクラス。

予測には、得られたEAT-BITE情報から考えられる候補を絞るSqueezeメソッドと、その候補の中から、良さそうな手を選ぶChoiceメソッド、良さそうな手を計算するcount_candメソッドからなります。良さそうな手とは、ある手を選んだ時に、返ってくるすべてのEAT-BITEの組み合わせから期待正解候補数が最も少ないものとしています。詳しくはnumer0nの必勝法を考えるを見てみてください。この理論に近いものを実装してます!

ちなみに平均コール数は5か6ぐらいだと思います(体感)。NumeronAI.javapackage server; import java.util.ArrayList; import java.util.List; public class NumeronAI { List<String> new_can_list = new ArrayList<>();//candidate list String can_num;//candidate number //考えられる候補数に絞る public NumeronAI Squeeze(int eat,int bite,String pred_num,String ca_num,List<String> old_list){ NumeronAI squeeze = new NumeronAI(); List<String> can_list = new ArrayList<>(); List<String> li = new ArrayList<>(); if(eat == 0 && bite == 0){ //System.out.println("--------" + String.valueOf(ca_num.length())); for(int i = 0; i<ca_num.length();i++){ if(ca_num.charAt(i) != pred_num.charAt(0) && ca_num.charAt(i) != pred_num.charAt(1) && ca_num.charAt(i) != pred_num.charAt(2)){ li.add(String.valueOf(ca_num.charAt(i))); } } ca_num =""; StringBuilder builder = new StringBuilder(); for(String num : li){ builder.append(num); } ca_num = builder.substring(0,builder.length()); for(int i = 0;i<ca_num.length();i++){ for(int j = 0;j<ca_num.length();j++){ for(int k = 0;k<ca_num.length();k++){ if(ca_num.charAt(i)!=ca_num.charAt(j) && ca_num.charAt(i)!=ca_num.charAt(k) && ca_num.charAt(j)!=ca_num.charAt(k)){ can_list.add(String.valueOf(ca_num.charAt(i))+String.valueOf(ca_num.charAt(j))+String.valueOf(ca_num.charAt(k))); } } } } }else if(eat ==0 && bite ==1){ for(int i = 0;i<ca_num.length();i++){ for(int j = 0;j<ca_num.length();j++){ if(ca_num.charAt(i) != ca_num.charAt(j) && ca_num.charAt(i)!=pred_num.charAt(0) && ca_num.charAt(i)!=pred_num.charAt(1) && ca_num.charAt(i)!=pred_num.charAt(2)){ can_list.add(String.valueOf(ca_num.charAt(i))+String.valueOf(pred_num.charAt(0))+String.valueOf(ca_num.charAt(j))); can_list.add(String.valueOf(ca_num.charAt(i))+String.valueOf(ca_num.charAt(j))+String.valueOf(pred_num.charAt(0))); can_list.add(String.valueOf(pred_num.charAt(1))+String.valueOf(ca_num.charAt(i))+String.valueOf(ca_num.charAt(j))); can_list.add(String.valueOf(ca_num.charAt(i))+String.valueOf(ca_num.charAt(j))+String.valueOf(pred_num.charAt(1))); can_list.add(String.valueOf(pred_num.charAt(2))+String.valueOf(ca_num.charAt(i))+String.valueOf(ca_num.charAt(j))); can_list.add(String.valueOf(ca_num.charAt(i))+String.valueOf(pred_num.charAt(2))+String.valueOf(ca_num.charAt(j))); } } } }else if(eat ==0 && bite ==2){ for(int i = 0;i<ca_num.length();i++){ if(ca_num.charAt(i)!=pred_num.charAt(0) && ca_num.charAt(i)!=pred_num.charAt(1) && ca_num.charAt(i)!=pred_num.charAt(2)){ can_list.add(String.valueOf(ca_num.charAt(i))+String.valueOf(pred_num.charAt(0))+String.valueOf(pred_num.charAt(1))); can_list.add(String.valueOf(ca_num.charAt(i))+String.valueOf(pred_num.charAt(2))+String.valueOf(pred_num.charAt(0))); can_list.add(String.valueOf(ca_num.charAt(i))+String.valueOf(pred_num.charAt(2))+String.valueOf(pred_num.charAt(1))); can_list.add(String.valueOf(pred_num.charAt(1))+String.valueOf(pred_num.charAt(0))+String.valueOf(ca_num.charAt(i))); can_list.add(String.valueOf(pred_num.charAt(1))+String.valueOf(ca_num.charAt(i))+String.valueOf(pred_num.charAt(0))); can_list.add(String.valueOf(pred_num.charAt(1))+String.valueOf(pred_num.charAt(2))+String.valueOf(ca_num.charAt(i))); can_list.add(String.valueOf(pred_num.charAt(2))+String.valueOf(ca_num.charAt(i))+String.valueOf(pred_num.charAt(0))); can_list.add(String.valueOf(pred_num.charAt(2))+String.valueOf(ca_num.charAt(i))+String.valueOf(pred_num.charAt(1))); can_list.add(String.valueOf(pred_num.charAt(2))+String.valueOf(pred_num.charAt(0))+String.valueOf(ca_num.charAt(i))); } } }else if(eat == 0 && bite ==3){ can_list.add(String.valueOf(pred_num.charAt(1))+String.valueOf(pred_num.charAt(2))+String.valueOf(pred_num.charAt(0))); can_list.add(String.valueOf(pred_num.charAt(2))+String.valueOf(pred_num.charAt(0))+String.valueOf(pred_num.charAt(1))); }else if(eat == 1 && bite ==0){ for(int i = 0;i<ca_num.length();i++){ for(int j = 0;j<ca_num.length();j++){ if(ca_num.charAt(i)!=ca_num.charAt(j) && ca_num.charAt(i)!=pred_num.charAt(0) && ca_num.charAt(i)!=pred_num.charAt(1) && ca_num.charAt(i)!=pred_num.charAt(2) && ca_num.charAt(j)!=pred_num.charAt(0) && ca_num.charAt(j)!=pred_num.charAt(1) && ca_num.charAt(j)!=pred_num.charAt(2)){ can_list.add(String.valueOf(pred_num.charAt(0))+String.valueOf(ca_num.charAt(i))+String.valueOf(ca_num.charAt(j))); can_list.add(String.valueOf(ca_num.charAt(i))+String.valueOf(pred_num.charAt(1))+String.valueOf(ca_num.charAt(j))); can_list.add(String.valueOf(ca_num.charAt(i))+String.valueOf(ca_num.charAt(j))+String.valueOf(pred_num.charAt(2))); } } } }else if(eat ==1 && bite ==1){ for(int i = 0;i<ca_num.length();i++){ if(ca_num.charAt(i)!=pred_num.charAt(0) && ca_num.charAt(i)!=pred_num.charAt(1) && ca_num.charAt(i)!=pred_num.charAt(2)){ can_list.add(String.valueOf(pred_num.charAt(0))+String.valueOf(ca_num.charAt(i))+String.valueOf(pred_num.charAt(1))); can_list.add(String.valueOf(pred_num.charAt(0))+String.valueOf(pred_num.charAt(2))+String.valueOf(ca_num.charAt(i))); can_list.add(String.valueOf(ca_num.charAt(i))+String.valueOf(pred_num.charAt(1))+String.valueOf(pred_num.charAt(0))); can_list.add(String.valueOf(pred_num.charAt(2))+String.valueOf(pred_num.charAt(1))+String.valueOf(ca_num.charAt(i))); can_list.add(String.valueOf(pred_num.charAt(1))+String.valueOf(ca_num.charAt(i))+String.valueOf(pred_num.charAt(2))); can_list.add(String.valueOf(ca_num.charAt(i))+String.valueOf(pred_num.charAt(0))+String.valueOf(pred_num.charAt(2))); } } }else if(eat ==1 && bite ==2){ for(int i = 0;i<ca_num.length();i++){ can_list.add(String.valueOf(pred_num.charAt(0))+String.valueOf(pred_num.charAt(2))+String.valueOf(pred_num.charAt(1))); can_list.add(String.valueOf(pred_num.charAt(2))+String.valueOf(pred_num.charAt(1))+String.valueOf(pred_num.charAt(0))); can_list.add(String.valueOf(pred_num.charAt(1))+String.valueOf(pred_num.charAt(0))+String.valueOf(pred_num.charAt(2))); } }else if(eat ==2 && bite ==0){ for(int i = 0;i<ca_num.length();i++){ if(ca_num.charAt(i)!=pred_num.charAt(0) && ca_num.charAt(i)!=pred_num.charAt(1) && ca_num.charAt(i)!=pred_num.charAt(2)){ can_list.add(String.valueOf(pred_num.charAt(0))+String.valueOf(pred_num.charAt(1))+String.valueOf(ca_num.charAt(i))); can_list.add(String.valueOf(pred_num.charAt(0))+String.valueOf(ca_num.charAt(i))+String.valueOf(pred_num.charAt(2))); can_list.add(String.valueOf(ca_num.charAt(i))+String.valueOf(pred_num.charAt(1))+String.valueOf(pred_num.charAt(2))); } } }else if(eat ==3 && bite ==0){ can_list.add(pred_num); } if(old_list.size()!=0){ for(String num : can_list){ if(old_list.contains(num)){ squeeze.new_can_list.add(num); squeeze.can_num =ca_num; } } }else{ squeeze.new_can_list = can_list; squeeze.can_num = ca_num; } //System.out.println(can_num); return squeeze; } //期待候補数を計算する public double count_cand(String pred_num,String ca_num,List<String> ca_list){ double ave_ca = 0; int[][] info_list = {{0,0},{0,1},{0,2},{0,3},{1,0},{1,1},{1,2},{2,1},{3,0}}; int sum_ex = 0; int sum_ex2 = 0; List<String> old_count_list = new ArrayList<>(ca_list); String ca_count_num = ca_num; NumeronAI squeeze2 = new NumeronAI(); for(int[] info :info_list){ squeeze2 = Squeeze(info[0],info[1],pred_num,ca_count_num,old_count_list); sum_ex=sum_ex+squeeze2.new_can_list.size(); sum_ex2=sum_ex2+squeeze2.new_can_list.size()^2; } if(sum_ex!=0){ ave_ca=sum_ex2/sum_ex; } return ave_ca; } //期待候補数が最小の数値を選択する public String choice(List<String> ca_list,String ca_num){ List<Double> ave_list = new ArrayList<>(); int min_index =0; try{ for(String num :ca_list){ double ave_ca = count_cand(num,ca_num,ca_list); ave_list.add(ave_ca); } double min =ave_list.get(0); for(int i =0;i<ave_list.size();i++){ double val = ave_list.get(i); if(min > val){ min = val; min_index = i; } } return ca_list.get(min_index); }catch(Exception e){ System.out.println("チョイスミス:" + e); return "111"; } } }実行結果

感想

Javaはあまり書いたことがなかったけど一応自分の作りたかったものはできたと思います。

しかしまだまだ、デザインパターンの知識を実践するレベルには至ってないので、勉強する必要があるなぁと実感しました。(デザインパターン難しい...)

Numer0nのAI(AIとあまり言いたくないけど)を自分の手で書いてみるのは、Numer0nを知っていて、なにか作ってみたいという方には、ルールも分かりやすいのでオススメです!あと、pythonでもNumeronAIの部分だけ作成したのでJavaは書いてないけどpythonならわかるよって方は良かったら参考にしてみてください。

Qiitaの投稿はこれが初めてなので、Qiitaの先輩方、この記事について改善点などありましたら是非コメントよろしくお願いします<(_ _)>

これから少しずつアウトプットしていけるよう頑張ります!

- 投稿日:2020-01-22T18:23:11+09:00

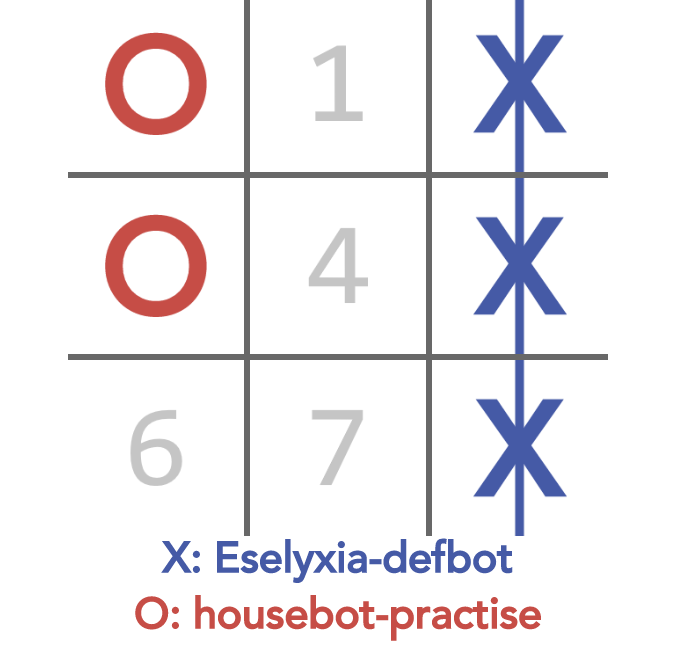

AI Gaming はじめてみた

TL;DR

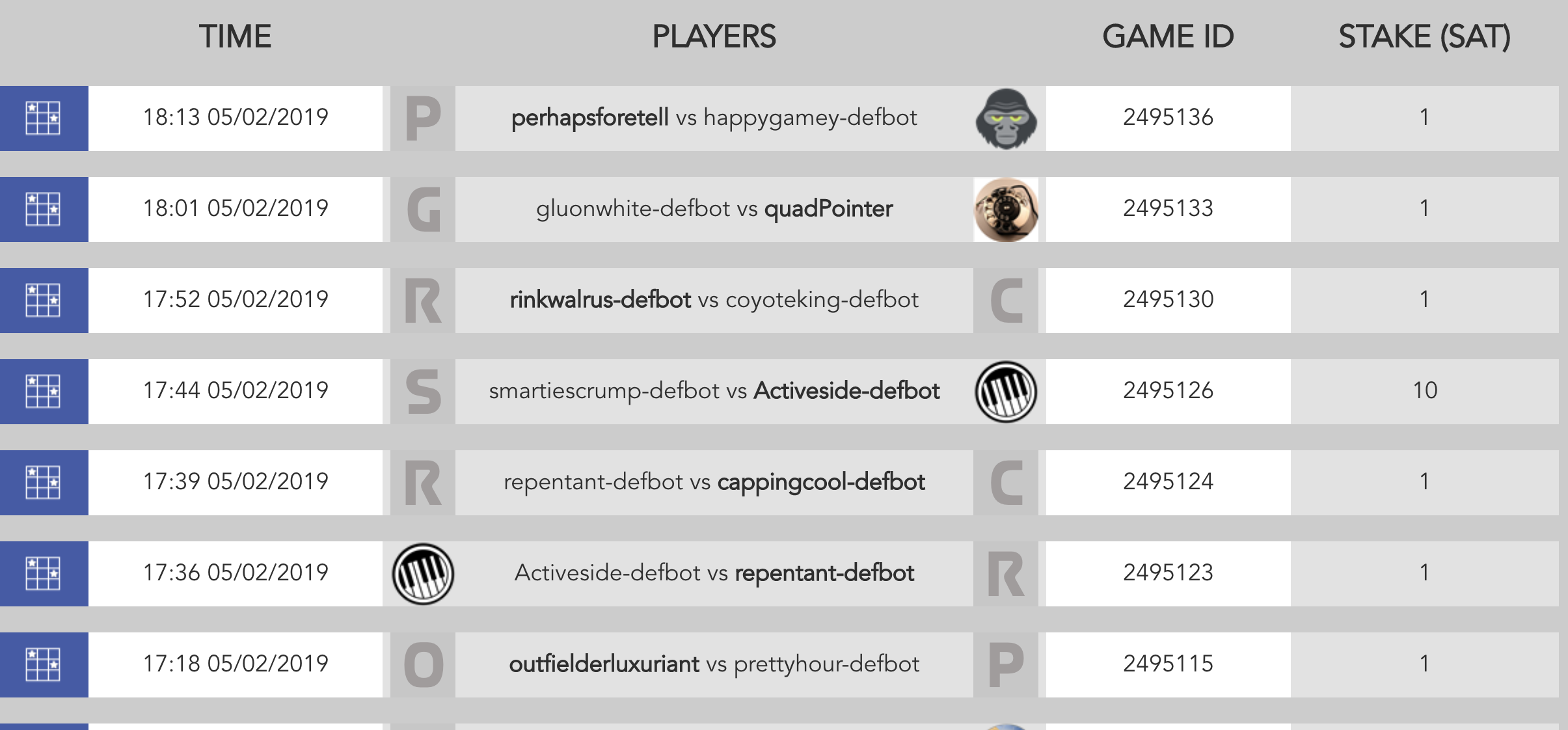

https://www.aigaming.com がBitCoinを賭けて戦う、バトルフィールドだ!!

AIやpythonに興味があれば、一緒に参加しよう!!この記事は

pythonもAIも初学者なnoyaがAI Gamingというプラットフォームで学習をはじめたというお話

AI Gamingとは

AIgaming.com is a platform that allows computer programs (bots) to challenge each other in games, puzzles and competitions, with the added incentive of winning cryptocurrency (Bitcoin and Satoshi)

プレイヤーがお互いに対戦型ゲーム(○×ゲームとか、囲碁とか)をするBotを作成し、仮想通貨を賭けて競うためのプラットフォームです。とのこと。実際は、Oppoturnityについて入れたりする欄もあるので、AI人材を見つけるための基盤としての一面もあるのでしょうが、Oppoturnityに関しては無視することもできるので、気にせず登録してよいかと思います。

How to Start

登録作業はとても簡単。さすが洗練されてきていますね。

- https://www.aigaming.com にアクセス

- 右上のRegisterから登録

- 必要事項を入力後、ダッシュボードがアクティベートされます

どんなゲームがあるの?

簡単なゲームから難しいゲームまで20種類くらいのゲームがリリースされています。

Nought and Crosses

Battle Ship

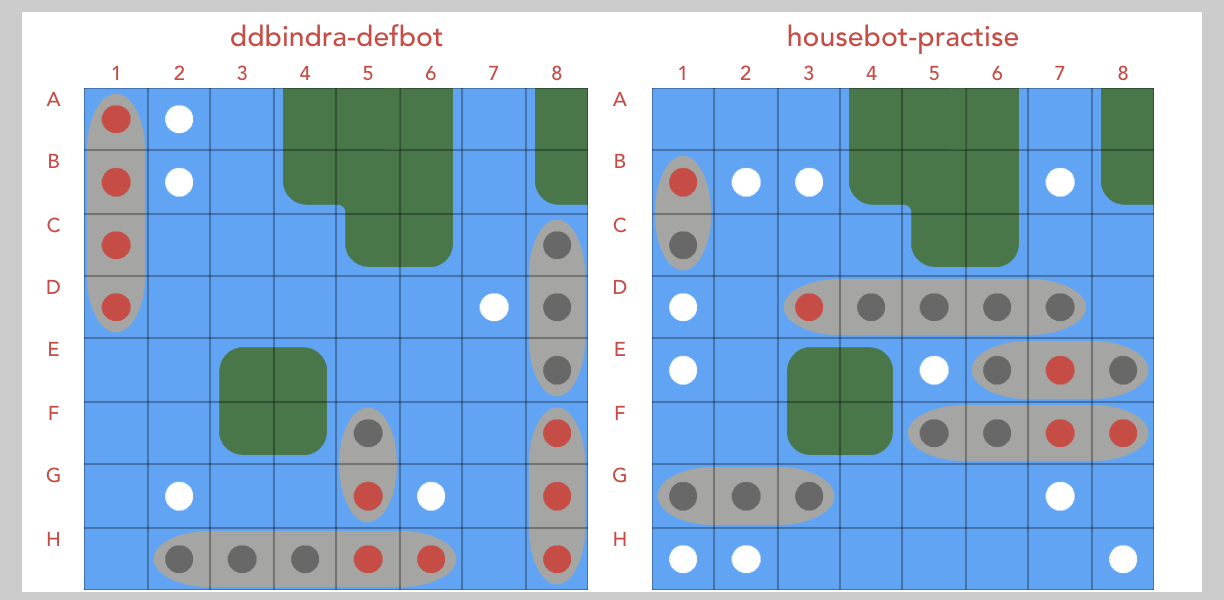

相手の船を見つけて、早く全滅させた方が勝ち。(お互いに船の位置は見えておらず、着弾時の情報から場所を推測しています)

Match game

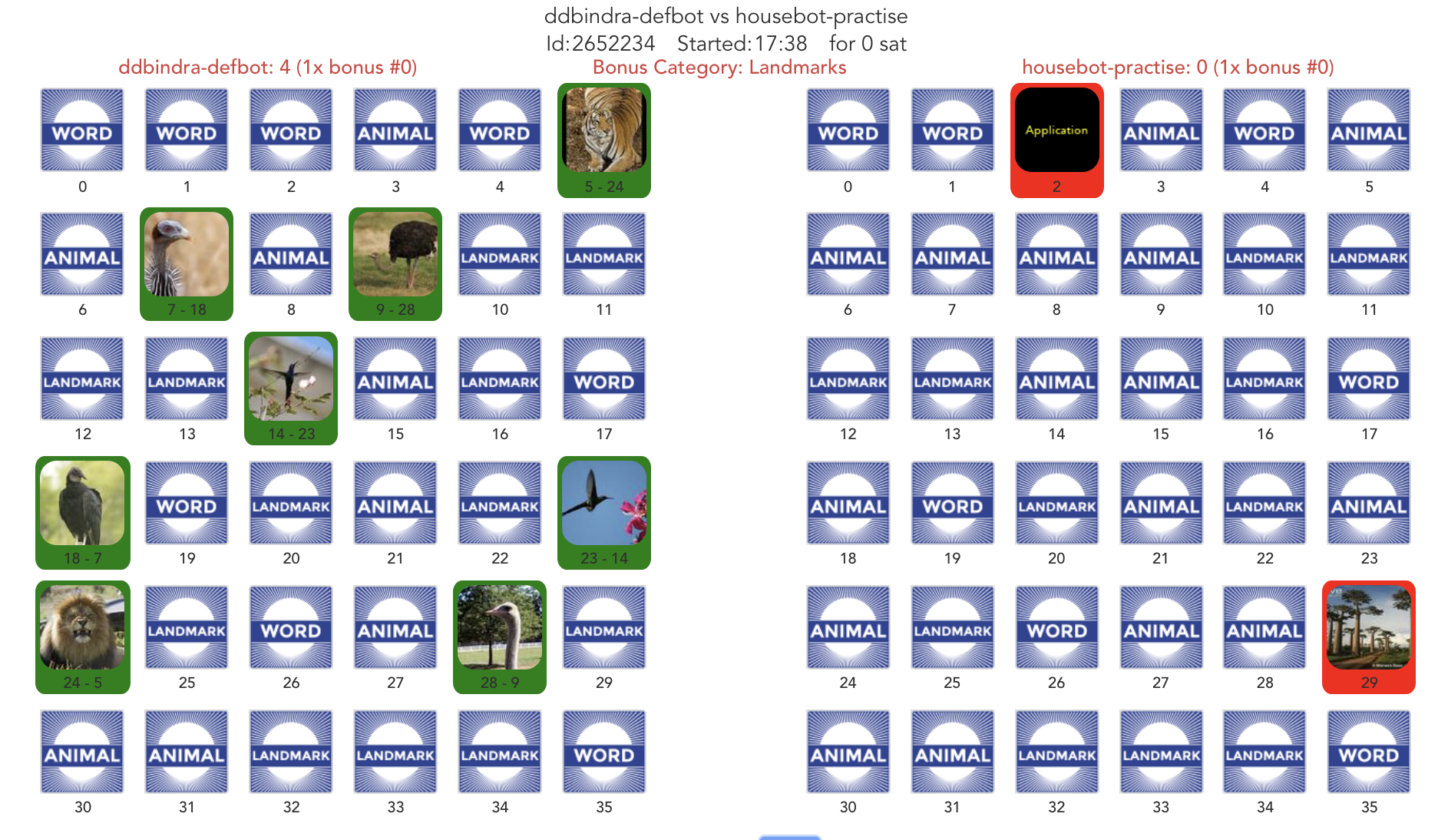

2枚のパネルを開いて、同じならポイント獲得!な神経衰弱。パネルの裏も表も画像のURLが渡されるので、まずはそれぞれのパネルが何なのか(動物・言葉・場所)を判断し、無駄なオープンを減らすところからスタートか。

BitCoinの稼ぎ方

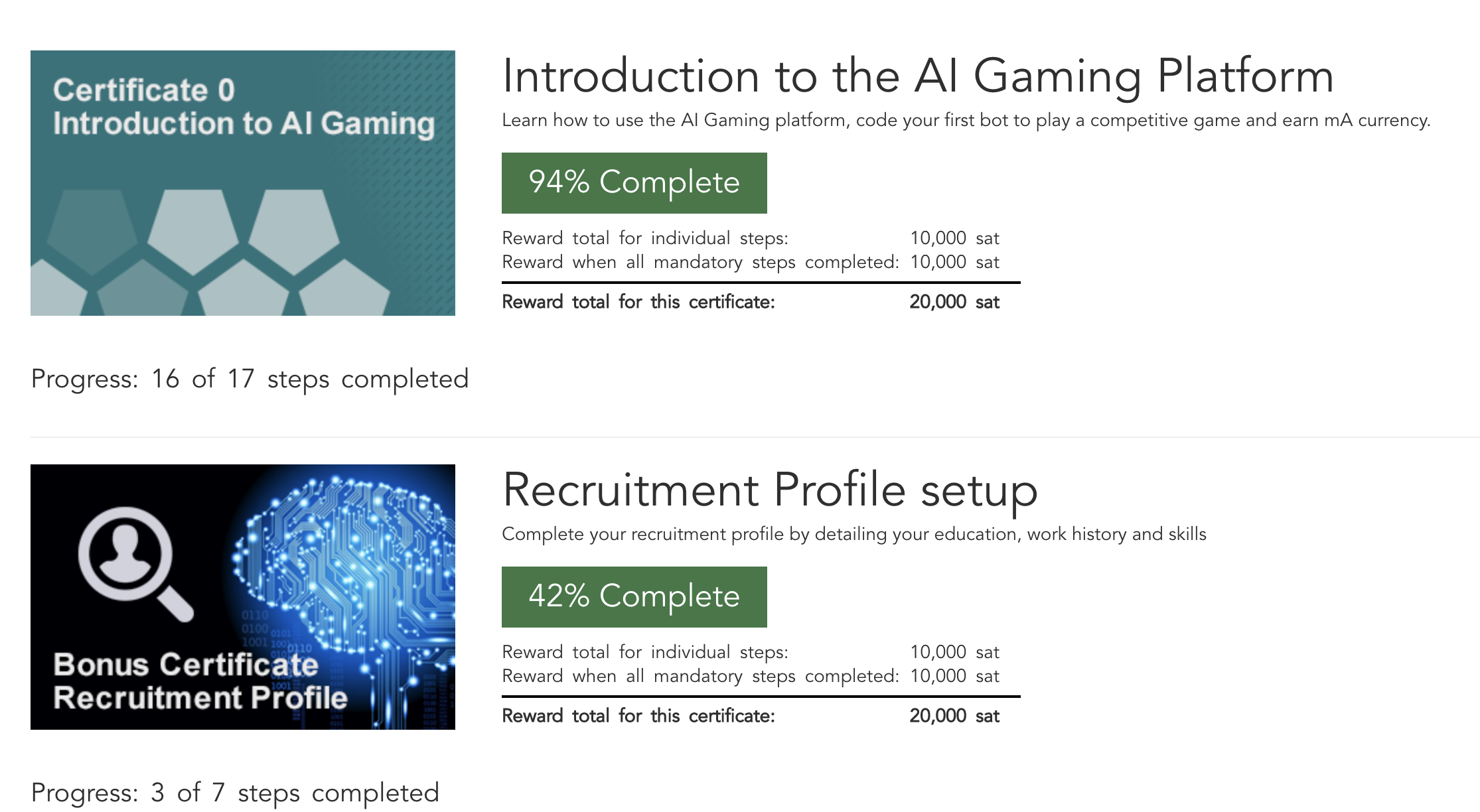

Missionをクリア

登録時にいくらかのSatoshiが配布され、ミッションを進めていくことでSatoshiを増やしていくことができます。現在で最大4万Satoshiまで獲得できる模様。

最初はあまり気にしなくても、○×ゲームをやっていれば、3000Satoshiくらいにはなっていました。中には練習用Botと100連戦して50%以上の勝率をマークせよ、なんていうのもあります。

Betして勝つ

Satoshiを賭けて戦うこともできます。ただ、賭けて戦うケースはまだ稀みたいです。将来、貯めたSatoshiを全額投入!みたいなバトルがみられたりもするのでしょうか。

引き出し方

調べ中。(あまり興味がない)

遊び方

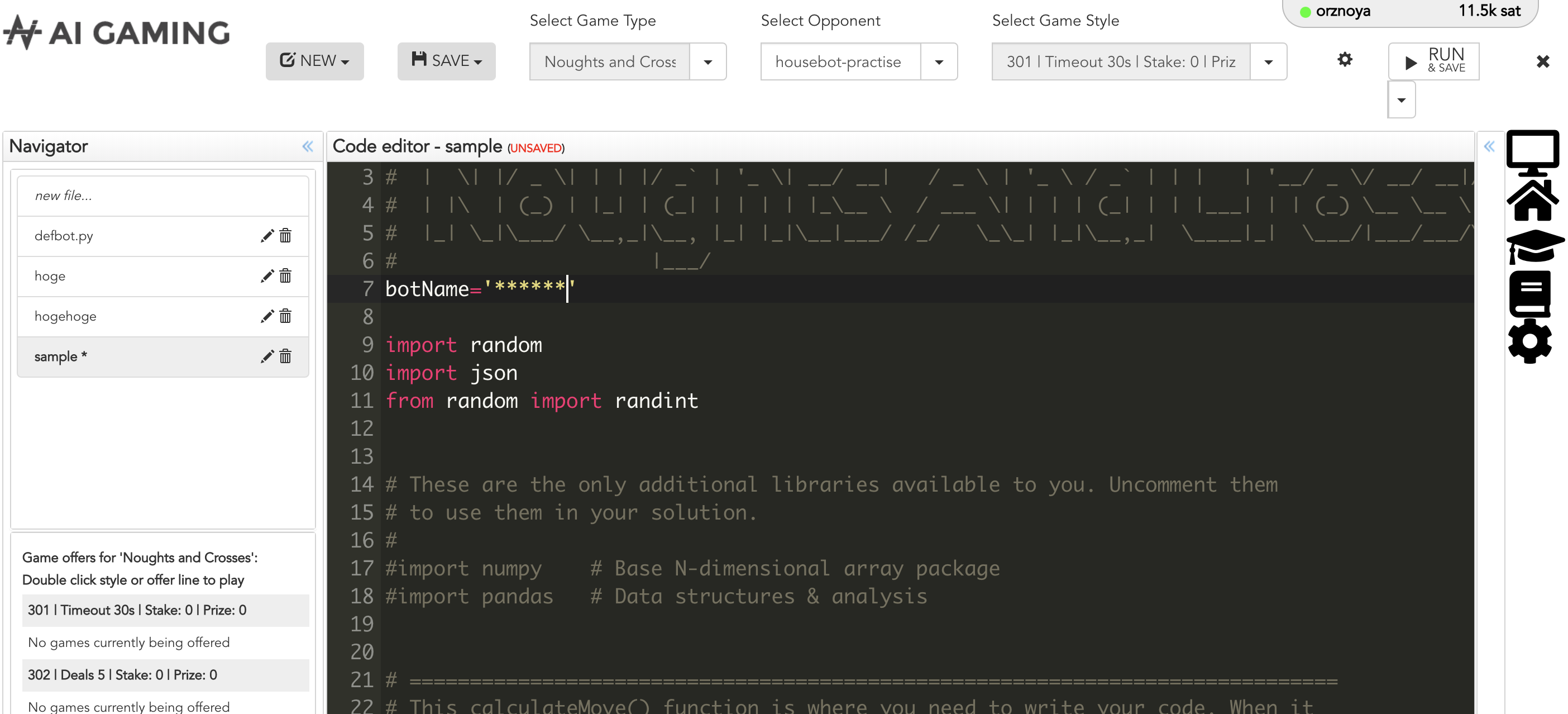

上部メニューの”EDITOR"からコーディング画面に入れます。

そのあと、Select Game Typeでゲームを選択すると、それぞれのゲームで「とりあえず動く」Botコードが記述されています。何もせずに右上のRunを押せば大抵の場合、ゲームが始まって、そして負けると思います。

Trouble

自分の場合は登録したあとに、ユーザアカウント名が気に入らなかったので変更したのですが、その場合botの名前が登録済みのBotの名前と一致せずゲームがはじめらませんでした。

デフォルトのBotの名前は(アカウント名)-defbotになっているのでMY ACCOUNT >> BOT MANAGEMENTで対応するBotを生成するか、旧アカウント名のBotを使うかなど、対応します。Coding

Sampleを参考にコーディングしましょう。

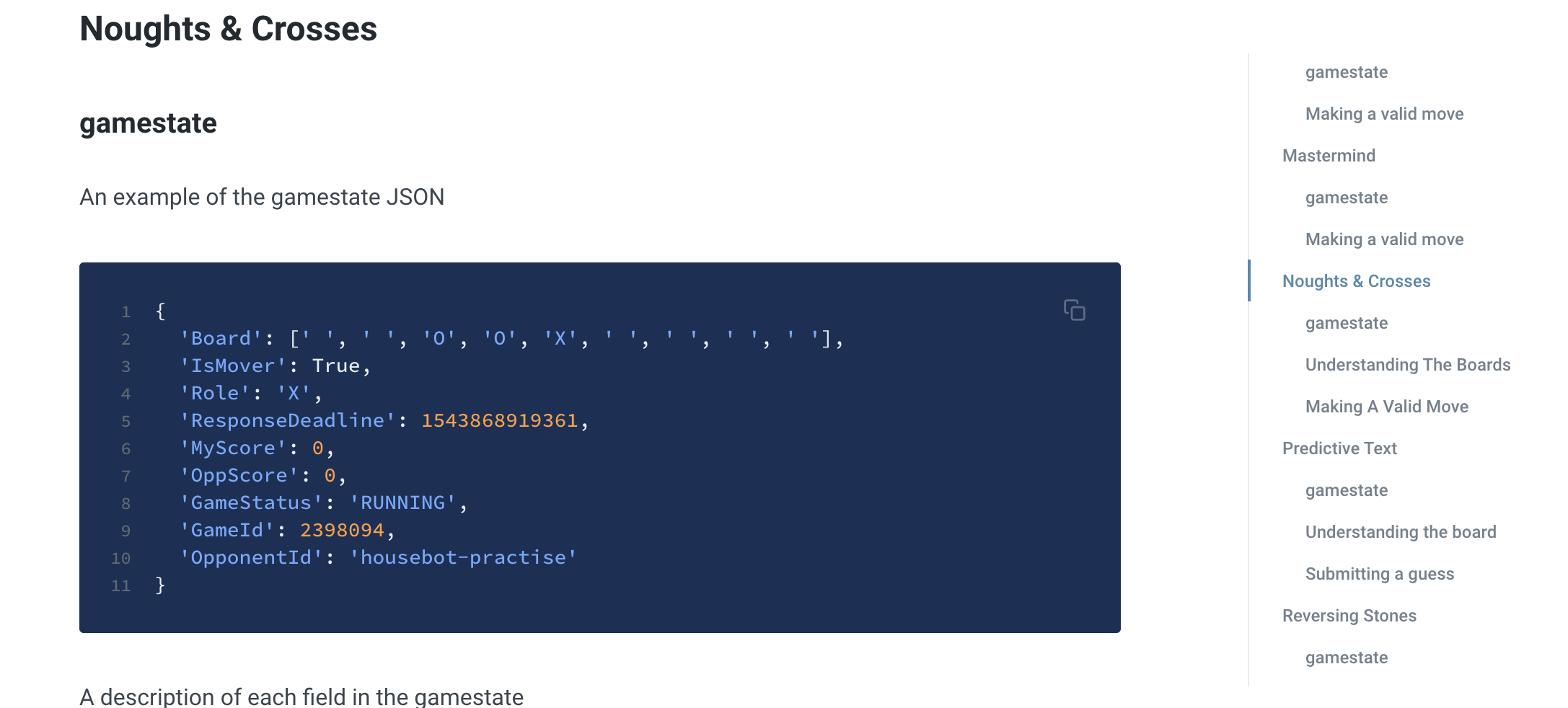

基本的にはゲームマスタが交代にとある関数にゲームの情報を引数として呼び出す(○×ゲームの場合はcalculateMove(gameState))ので、その中身を実装します。

gameStateの構造や返し値のフォーマットについては、https://www.aigaming.com/Help の各ゲームの説明かProgrammer’s Referenceにかなり丁寧に記載されています。○×ゲームの場合は

gameState.Boardで一次元の配列としてボードの状態が引き渡されるので、これを理解して、自分のマークを置く位置nを{Positison: n}というJSONオブジェクトで返せばOKです。対戦を始める

Select Opponentのドロップダウンで対戦相手を選択可能です。

- housebot-practice : 弱いBot。まずはこいつに勝ちましょう。

- housebot-competition : 強いBot。筆者は現時点でまだ勝ててません。

対戦相手を指定する

ドロップダウンではなく、直接入力することで、対戦するBotを指名可能です。

面白いのは、自分自身とも対戦できるという点です。ブラウザを2面開いて、お互いに指名し合ってRunすれば、対戦可能です。(自分の作ったBot同士で対戦する、というミッションもあるので、是非とも試してみてください)

これからやってみようと思うこと

- competition Botに勝つ

- 画像認識や自然文解析のクラウド基盤と連携して、他のゲームに挑戦する

まとめ

以上、簡単にAI Gamingについてご紹介しました。ブラウザで完結し、気軽にpythonおよびAIについて、各自のレベルに合わせて学習できる、良い基盤だと思います。

それでは今回はこの辺で。

- 投稿日:2020-01-22T18:21:58+09:00

Django REST framework躓きどころ

Method Not Allowed:405

- requestsのメソッド

- postとputを間違えていた

401 Unauthorized

- 権限をなくす設定

- 'DEFAULT_PERMISSION_CLASSES': ['rest_framework.permissions.AllowAny']

URLの仕組み

- GET: api/book/

- POST: api/book/

- PUT: api/book/1/

Serializer

fields = '__all__'を駆使する'required': Falseを駆使するserializer.pyclass HistorySerializer(serializers.ModelSerializer): class Meta: model = History fields = '__all__' extra_kwargs = { 'id': {'required': False}, 'start_at': {'required': False}, }

- 投稿日:2020-01-22T18:16:55+09:00

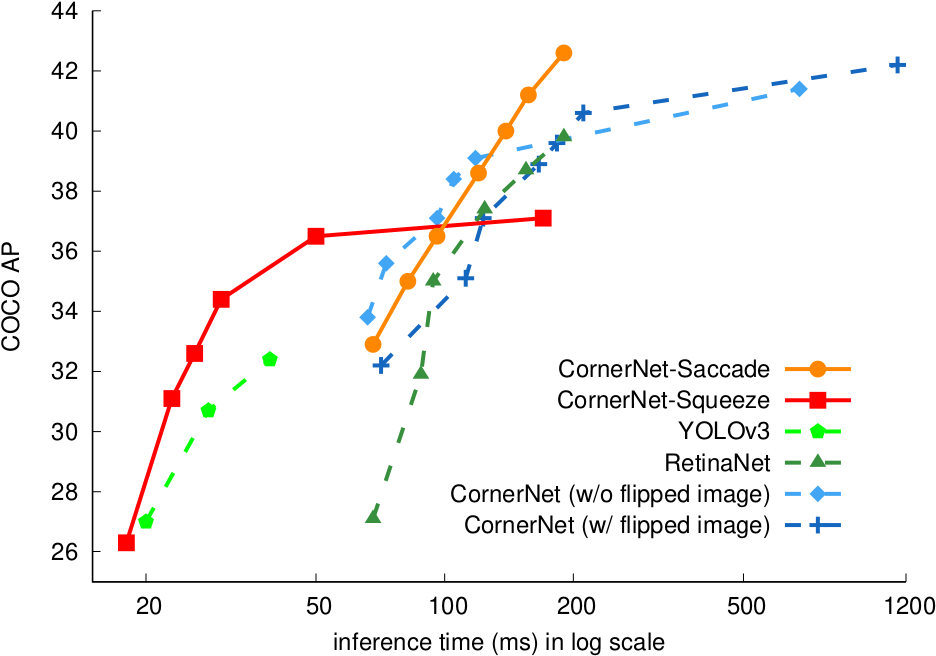

精度をちょっぴり落としたら、重みパラメータが信じられない程減らせた 〜 CNNの驚きの結果 〜

1.はじめに

ニューラルネットワークの画像識別については、通常どこまで精度が上げられるかが注目されますが、私は天邪鬼なので、精度をちょっぴり落としたら、どれだけ重みパラメータが減らせるかに注目してみます。

ニューラルネットワークは精度の最後1〜2%を上げるために、リソースの大半が使われることが多いと思うので、精度を1〜2%程度犠牲にしただけでも、結構重みパラメーターを減らせるはずです。

今回実験に使うモデルは、kerasのチュートリアルに載っている、MNIST(0〜9の手書き数字)を識別するMLP(多層パーセプトロン)とCNN(畳み込みネットワーク)を使います。この2つのモデルの精度は98〜99%くらいなので、目標精度は97%台として、重みパラメータをどれだけ減らすことが出来るかを試してみます。

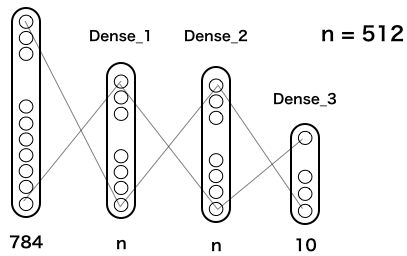

2.MLP(多層パーセプトロン)

これが、kerasチュートリアルに載っている、MLPの基本構造です(実際は、これに Dropout が2つ追加してありますが、単純化するために省略してあります)。

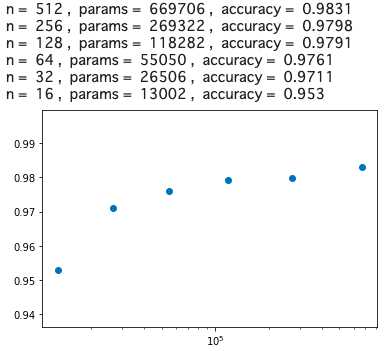

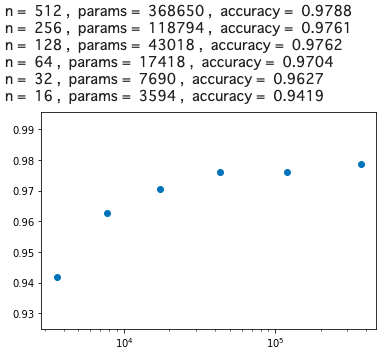

MNISTは28*28ピクセルなので、入力は28*28=784個。隠れ層は2層でいずれも n = 512個で全結合されています。この n を順次小さくしたら精度はどうなって行くのかをまず確認してみましょう。次のコードを実行します(実行時間は、google colab のGPUで3分半程度)。

from __future__ import print_function import keras from keras.datasets import mnist from keras.models import Sequential from keras.layers import Dense, Dropout from keras.optimizers import RMSprop batch_size = 128 num_classes = 10 epochs = 20 # load data (x_train, y_train), (x_test, y_test) = mnist.load_data() x_train = x_train.reshape(60000, 784) x_test = x_test.reshape(10000, 784) x_train = x_train.astype('float32') x_test = x_test.astype('float32') x_train /= 255 x_test /= 255 y_train = keras.utils.to_categorical(y_train, num_classes) y_test = keras.utils.to_categorical(y_test, num_classes) # multi Perceptoron_1 def mlp(n): model = Sequential() model.add(Dense(n, activation='relu', input_shape=(784,))) model.add(Dense(n, activation='relu')) model.add(Dense(num_classes, activation='softmax')) #model.summary() model.compile(loss='categorical_crossentropy', optimizer=RMSprop(), metrics=['accuracy']) model.fit(x_train, y_train, batch_size=batch_size, epochs=epochs, verbose=0, validation_data=(x_test, y_test)) score = model.evaluate(x_test, y_test, verbose=0) return score[1] # test list_n = [512, 256, 128, 64, 32, 16] x, y = [], [] for n in list_n: params = n*n + 796*n + 10 acc = mlp(n) x.append(params) y.append(acc) print ('n = ', n, ', ', 'params = ', params, ', ', 'accuracy = ', acc) # graph import matplotlib.pyplot as plt plt.scatter(x, y) plt.xscale('log') plt.show()

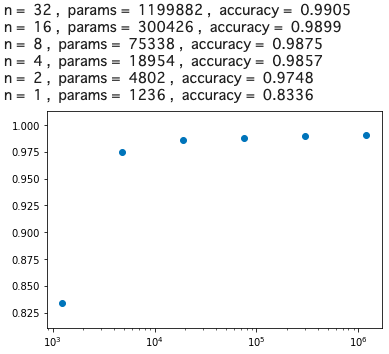

グラフの横軸は重みパラメータ数(log)、縦軸は精度です。精度97%を確保しようとすると、n = 32, params = 26506, accuracy = 0.9711 が分岐点でしょうか。そうすると、精度を若干犠牲にすることによって、669706/26506 = 25.26 なのでベースモデルの約1/25まで、重みパラメータを減らせるわけです。

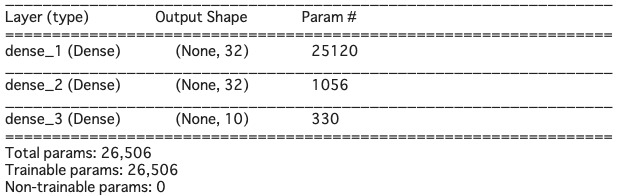

model.summary() でモデルの概要を見てみると(先頭の#を取って実行すると表示されます)、こんな感じ

これ以上重みパラメータを減らすことは無理でしょうか。いえ、まだ別の手があります。重みパラメータを一番消費するところはどこでしょうか。入力784個とdense_1のところで、(784+1)*32=25120 と全体の重みパラメータの95%はここで消費されているわけです。ちなみに、784+1となるのは、バイアス分が1あるからです。

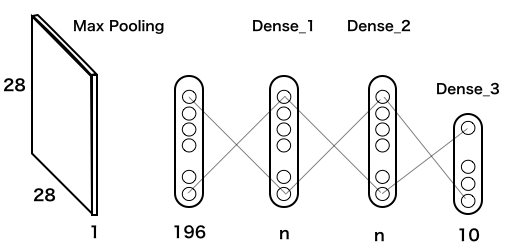

数字の解像度が悪くても、ある程度は識別出来るだろうと仮説を立て、28*28=784個の入力をフイルター(Max Pooling)を使って、1/4の14*14=196個にするモデルを考えます。

このモデルのコードを実行します(実行時間は、google colab のGPUで3分半程度)。from __future__ import print_function import keras from keras.datasets import mnist from keras.models import Sequential from keras.layers import Dense, Dropout from keras.optimizers import RMSprop from keras.layers import MaxPooling2D, Flatten # 追加 batch_size = 128 num_classes = 10 epochs = 20 # load data (x_train, y_train), (x_test, y_test) = mnist.load_data() x_train = x_train.reshape(60000, 28, 28, 1) # 変更 x_test = x_test.reshape(10000, 28, 28, 1) # 変更 x_train = x_train.astype('float32') x_test = x_test.astype('float32') x_train /= 255 x_test /= 255 y_train = keras.utils.to_categorical(y_train, num_classes) y_test = keras.utils.to_categorical(y_test, num_classes) # multi Perceptoron_2 def mlp(n): model = Sequential() model.add(MaxPooling2D(pool_size=(2, 2),input_shape=(28, 28, 1))) # 画像を14*14に縮小 model.add(Flatten()) # 全結合にする model.add(Dense(n, activation='relu')) model.add(Dense(n, activation='relu')) model.add(Dense(num_classes, activation='softmax')) #model.summary() model.compile(loss='categorical_crossentropy', optimizer=RMSprop(), metrics=['accuracy']) model.fit(x_train, y_train, batch_size=batch_size, epochs=epochs, verbose=0, validation_data=(x_test, y_test)) score = model.evaluate(x_test, y_test, verbose=0) return score[1] # test list_n = [512, 256, 128, 64, 32, 16] x, y = [], [] for n in list_n: params = n*n + 208*n + 10 # モデル変更 acc = mlp(n) x.append(params) y.append(acc) print ('n = ', n, ', ', 'params = ', params, ', ', 'accuracy = ', acc) # graph import matplotlib.pyplot as plt plt.scatter(x, y) plt.xscale('log') plt.show()

全体的に、若干精度の悪い方へスライドしましたが、n = 64, params = 17418, accuracy = 0.9704 が分岐点になりました。そうすると、精度を若干犠牲にすることによって、669706/17418=38.44 ということで、ベースモデルの約1/38まで重みパラメータを減らすことが出来ることが分かりました。結構減らせるものですね。

3.CNNの驚くべき結果

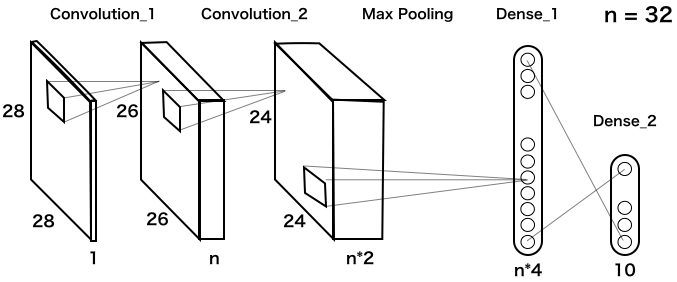

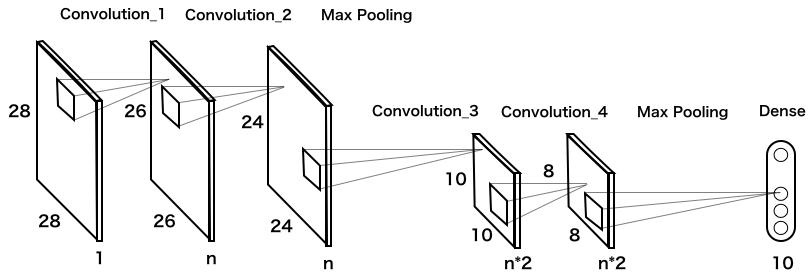

これが、kerasチュートリアルに載っている、CNNの基本構造です(実際は、これに Dropout が2つ追加してありますが、単純化するために省略してあります)。

2つある畳み込み層は、3*3=9のフィルターを使っています。その後、Max Poolingで縦横それぞれ1/2に縮小し、n*4の全結合層に繋げています。では、nを変化させた時の重みパラメータの数と精度を見てみましょう。次のコードを実行します(実行時間は、google colab のGPUで3分半程度)。

from __future__ import print_function import keras from keras.datasets import mnist from keras.models import Sequential from keras.layers import Dense, Dropout, Flatten from keras.layers import Conv2D, MaxPooling2D from keras import backend as K batch_size = 128 num_classes = 10 epochs = 12 img_rows, img_cols = 28, 28 # load data (x_train, y_train), (x_test, y_test) = mnist.load_data() if K.image_data_format() == 'channels_first': x_train = x_train.reshape(x_train.shape[0], 1, img_rows, img_cols) x_test = x_test.reshape(x_test.shape[0], 1, img_rows, img_cols) input_shape = (1, img_rows, img_cols) else: x_train = x_train.reshape(x_train.shape[0], img_rows, img_cols, 1) x_test = x_test.reshape(x_test.shape[0], img_rows, img_cols, 1) input_shape = (img_rows, img_cols, 1) x_train = x_train.astype('float32') x_test = x_test.astype('float32') x_train /= 255 x_test /= 255 y_train = keras.utils.to_categorical(y_train, num_classes) y_test = keras.utils.to_categorical(y_test, num_classes) # CNN_1 def cnn(n): model = Sequential() model.add(Conv2D(n, kernel_size=(3, 3), activation='relu', input_shape=input_shape)) model.add(Conv2D(n*2, (3, 3), activation='relu')) model.add(MaxPooling2D(pool_size=(2, 2))) model.add(Flatten()) model.add(Dense(n*4, activation='relu')) model.add(Dense(num_classes, activation='softmax')) #model.summary() model.compile(loss=keras.losses.categorical_crossentropy, optimizer=keras.optimizers.Adadelta(), metrics=['accuracy']) model.fit(x_train, y_train, batch_size=batch_size, epochs=epochs, verbose=0, validation_data=(x_test, y_test)) score = model.evaluate(x_test, y_test, verbose=0) return score[1] # test list_n = [32, 16, 8, 4, 2, 1] x, y = [], [] for n in list_n: params = 1170*n*n + 56*n + 10 acc = cnn(n) x.append(params) y.append(acc) print ('n = ', n, ', ', 'params = ', params, ', ', 'accuracy = ', acc) # graph import matplotlib.pyplot as plt plt.scatter(x, y) plt.xscale('log') plt.show()

これは凄い! 分岐点は、n = 2, params = 4802, accuracy = 0.9748 です。そうすると、精度を若干犠牲にすることによって、1199882/4802=249.8 なのでベースモデルの約1/250まで重みパラメータの数を減らすことが出来たわけです。

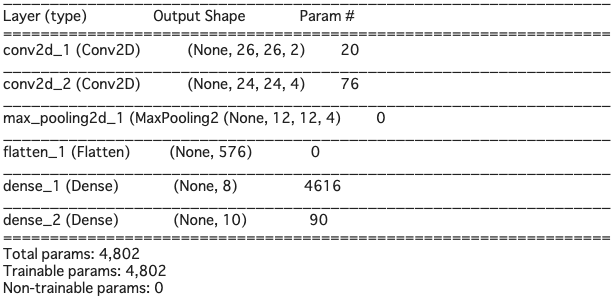

さて、先程同様、model.summary()でモデルの概要を見てみると、

MLPとは逆で、入力と畳み込みの部分はパラメータの数は少ないです。畳み込み層のパラメータは、3*3=9個のフィルターが共通で使われるので、重みパラメータが少なくなります。その代わりに、最終の畳み込み層から全結合に入るところが、(12*12*4+1)*8=4616 で、全体の重みパラメータの96%を占めています。ここを何とか出来ないか。

畳み込み層は、ほとんど重みパラメータを消費しないので、Max Poolingの後に再度畳み込み層を2つ入れて、さらにMax Poolingを掛けたらどうかというのが、以下のモデルです。

では、このモデルのコードを実行します(実行時間は、google colab のGPUで3分半程度)。from __future__ import print_function import keras from keras.datasets import mnist from keras.models import Sequential from keras.layers import Dense, Dropout, Flatten from keras.layers import Conv2D, MaxPooling2D from keras import backend as K batch_size = 128 num_classes = 10 epochs = 12 img_rows, img_cols = 28, 28 # load data (x_train, y_train), (x_test, y_test) = mnist.load_data() if K.image_data_format() == 'channels_first': x_train = x_train.reshape(x_train.shape[0], 1, img_rows, img_cols) x_test = x_test.reshape(x_test.shape[0], 1, img_rows, img_cols) input_shape = (1, img_rows, img_cols) else: x_train = x_train.reshape(x_train.shape[0], img_rows, img_cols, 1) x_test = x_test.reshape(x_test.shape[0], img_rows, img_cols, 1) input_shape = (img_rows, img_cols, 1) x_train = x_train.astype('float32') x_test = x_test.astype('float32') x_train /= 255 x_test /= 255 y_train = keras.utils.to_categorical(y_train, num_classes) y_test = keras.utils.to_categorical(y_test, num_classes) # CNN_2 def cnn(n): model = Sequential() model.add(Conv2D(n, kernel_size=(3, 3), activation='relu', input_shape=input_shape)) model.add(Conv2D(n, (3, 3), activation='relu')) model.add(MaxPooling2D(pool_size=(2, 2))) model.add(Conv2D(n*2, (3, 3), activation='relu')) model.add(Conv2D(n*2, (3, 3), activation='relu')) model.add(MaxPooling2D(pool_size=(2, 2))) model.add(Flatten()) model.add(Dense(num_classes, activation='softmax')) #model.summary() model.compile(loss=keras.losses.categorical_crossentropy, optimizer=keras.optimizers.Adadelta(), metrics=['accuracy']) model.fit(x_train, y_train, batch_size=batch_size, epochs=epochs, verbose=0, validation_data=(x_test, y_test)) score = model.evaluate(x_test, y_test, verbose=0) return score[1] # test list_n = [32, 16, 8, 4, 2, 1] x, y = [], [] for n in list_n: params = 63*n*n + 335*n + 10 acc = cnn(n) x.append(params) y.append(acc) print ('n = ', n, ', ', 'params = ', params, ', ', 'accuracy = ', acc) # graph import matplotlib.pyplot as plt plt.scatter(x, y) plt.xscale('log') plt.show()

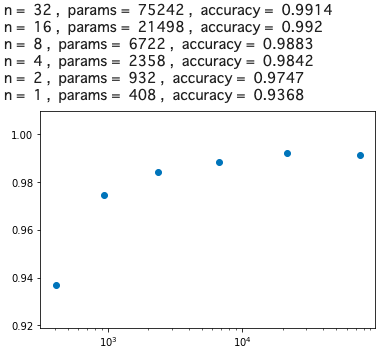

驚いたことに、重みパラメータ数がたった932個で、精度97%が確保出来ました。この重みパラメータ数は、ベースモデルのなんと1/1000以下です!そして、MLPの17418個と比べると、17418/932=18.68 で、MLPの約1/18の重みパラメータで同等の精度が得られることが分かりました。

画像認識においては、CNNの畳み込み層が極めて有効に働くことが大変良く分かる結果ですね。CNN、恐るべしです!

- 投稿日:2020-01-22T18:15:05+09:00

字幕から文字抽出してみた(OpenCV:GoogleCloudVisionAPI編)

Motive

字幕から文字抽出してみた(OpenCV:tesseract-ocr編)の予告通りにGoogleCloudVisionAPIを使って字幕の文字を抽出してみたいと思います。

Method

まずGoogleCloudVisionAPIを使うにはgoogle cloud consoleにてアカウント登録してAPIキーを取得する必要があります。方法としては、Cloud Vision APIの使い方まとめ (サンプルコード付き)に書いてあるので参照してください。

import requests import json import base64 import cv2 import sys if __name__ == "__main__": KEY = "--- your api key ---" url = 'https://vision.googleapis.com/v1/images:annotate?key=' api_url = url + KEY # 画像読み込み img_file_path = sys.argv[1] mat = cv2.imread(img_file_path) # 字幕表示部分のみ roi = mat[435:600, :] # openCV -> base64 result, dst_data = cv2.imencode('.png', roi) img_content = base64.b64encode(dst_data) # リクエストBody作成 req_body = json.dumps({ 'requests': [{ 'image': { 'content': img_content.decode('utf-8') }, 'features': [{ 'type': 'DOCUMENT_TEXT_DETECTION' }] }] }) # リクエスト発行 res = requests.post(api_url, data=req_body) # リクエストから画像情報取得 res_json = res.json()['responses'] if 0 < len(res_json[0]): textobj = res_json[0]['textAnnotations'][0] print("".join(textobj["description"].strip().split("\n")))apiをリクエストするときは画像をbase64に文字列化してjsonを設計するのですが、

src = cv2.imread("image_path") result, dst_data = cv2.imencode('.png', src) img_content = base64.b64encode(dst_data)でopenCVからの変換ができます。

また、このまま最低限に逐次処理でAPIを呼び出しつつ文字抽出をすればいいのですが、

asyncioを使って並列処理をすれば処理スピードが上がります。asyncioを使う理由としてはmultiprocessing.Poolよりはコルーチン内でAPIのレスポンス処理をブロックしていて安定しているためです。async def main_image_process(src): #文字認識しやすいように加工 gray_frame = pre_process(src.content) #テロップが出そうなところだけトリミング roi = gray_frame[435:600, :] #テキストを抽出 text = await extractTelopText(roi) await asyncio.sleep(2) dst = await createFooterTelop(src.content) dst = await addJapaneseTelop(dst, text, 20, cap_height + telop_height - 30) dst = await addASCIITelop(dst, str(src.timestamp) + "[sec]", cap_width - 250, cap_height + telop_height - 10, color=(0,255,0)) return MovieFrame(src.id, dst, src.timestamp) if __name__ == "__main__": r = [] loop = asyncio.get_event_loop() try: r = loop.run_until_complete( asyncio.gather(*[main_image_process(f) for f in frames]) ) finally: loop.close()Python3.7以降だともっとシンプルに記述できるみたいですが、まだ安定しておらずcentOSのデフォルトパッケージがPython3.6だったので3.6ベースで書いています。

Development

コード全体です。

import sys import cv2 import io import os import numpy as np import base64 import json import requests import asyncio from PIL import Image, ImageDraw, ImageFont from collections import namedtuple import time MovieFrame = namedtuple("MovieFrame", ["id", "content", "timestamp"]) telop_height = 50 cap_width = 1 cap_height = 1 def pre_process(src): kernel = np.ones((3,3),np.uint8) gray = cv2.cvtColor(src, cv2.COLOR_BGR2GRAY) o_ret, o_dst = cv2.threshold(gray, 0, 255, cv2.THRESH_OTSU) dst = cv2.morphologyEx(o_dst, cv2.MORPH_OPEN, kernel) dst = cv2.bitwise_not(dst) dst = cv2.cvtColor(dst, cv2.COLOR_GRAY2BGR) return dst async def extractTelopText(src): KEY = "--- your api key ---" url = 'https://vision.googleapis.com/v1/images:annotate?key=' api_url = url + KEY message = "" result, dst_data = cv2.imencode('.png', src) img_content = base64.b64encode(dst_data) # リクエストBody作成 req_body = json.dumps({ 'requests': [{ 'image': { 'content': img_content.decode('utf-8') }, 'features': [{ 'type': 'DOCUMENT_TEXT_DETECTION' }] }] }) # リクエスト発行 res = requests.post(api_url, data=req_body) # リクエストから画像情報取得 res_json = res.json()['responses'] if 0 < len(res_json[0]): textobj = res_json[0]["textAnnotations"][0] message = "".join(textobj["description"].strip().split("\n")) return message async def createFooterTelop(src): telop = np.zeros((telop_height, cap_width, 3), np.uint8) telop[:] = tuple((128,128,128)) images = [src, telop] dst = np.concatenate(images, axis=0) return dst async def main_image_process(src): #文字認識しやすいように加工 gray_frame = pre_process(src.content) #テロップが出そうなところだけトリミング roi = gray_frame[435:600, :] #テキストを抽出 text = await extractTelopText(roi) await asyncio.sleep(2) dst = await createFooterTelop(src.content) dst = await addJapaneseTelop(dst, text, 20, cap_height + telop_height - 30) dst = await addASCIITelop(dst, str(src.timestamp) + "[sec]", cap_width - 250, cap_height + telop_height - 10, color=(0,255,0)) return MovieFrame(src.id, dst, src.timestamp) async def addASCIITelop(src, sentence, px, py, color=(8,8,8), fsize=28): cv2.putText(src, sentence, (px, py), cv2.FONT_HERSHEY_SIMPLEX, 1, color, 2, cv2.LINE_AA) return src async def addJapaneseTelop(src, sentence, px, py, color=(8,8,8), fsize=28): rgbImg = cv2.cvtColor(src, cv2.COLOR_BGR2RGB) canvas = Image.fromarray(rgbImg).copy() draw = ImageDraw.Draw(canvas) font = ImageFont.truetype("./IPAfont00303/ipag.ttf", fsize) draw.text((px, py), sentence, fill=color, font=font) dst = cv2.cvtColor(np.array(canvas, dtype=np.uint8), cv2.COLOR_RGB2BGR) return dst if __name__ == '__main__': cap = cv2.VideoCapture('one_minutes.mp4') cap_width = int(cap.get(cv2.CAP_PROP_FRAME_WIDTH)) cap_height = int(cap.get(cv2.CAP_PROP_FRAME_HEIGHT)) fps = cap.get(cv2.CAP_PROP_FPS) telop_height = 50 fourcc = cv2.VideoWriter_fourcc('m','p','4','v') writer = cv2.VideoWriter('extract_telop_async.mp4',fourcc, fps, (cap_width, cap_height + telop_height)) frames = [] start = time.time() idx = 0 #read frame try : while True: if not cap.isOpened(): break if cv2.waitKey(1) & 0xFF == ord('q'): break ret, frame = cap.read() if frame is None: break frames.append(MovieFrame(idx,frame, round(idx/fps, 4)) ) idx += 1 except cv2.error as e: print(e) cap.release() print("read movie file") #process r = [] loop = asyncio.get_event_loop() try: r = loop.run_until_complete( asyncio.gather(*[main_image_process(f) for f in frames]) ) finally: loop.close() #sort sorted_out = sorted(r, key=lambda x: x.id) #write frame try : for item in sorted_out: writer.write(item.content) except cv2.error as e: print(e) writer.release() print("write movie file") print("Done!!! {}[sec]".format(round(time.time() - start,4)))Result

tesseract-ocr

GoogleCloudVisionAPI

処理時間:1315sec ≒ 21分

外部APIを使いつつ非同期処理をかけているので処理時間が結構かかりましたが、OCRの精度としてはGoogleCloudVisionAPIの方が良いのがわかると思います。

Future

次回は画像修復(inpaint)を使ってオブジェクト消去したった(OpenCV:C++)を動画編集しようかなと思っているのですが、今回使ったコードをもとにC++にしようかなと思っています。

となると、

- curlの使い方

- thread(そもそもあるのかasyncioと同等のライブラリがあるのか?)

を処理するにはどうすればいいか考えないといかんとです。

boostを使うしかないか。Reference

- 投稿日:2020-01-22T17:57:46+09:00

Shotgun APIを初めて使う方へ - データ操作編・後編 -

データ操作編・前編では、Shotgun APIを使用してProjectの作成、取得、更新を行う方法をご紹介しました

今回は、Projectに紐づくEntityのデータ操作方法をご紹介します

前回の記事で作成したフォルダやモジュールを使用して進めますので、

まだ前回の記事をご覧になっていない場合は、そちらから先にご覧頂ければ幸いですProjectに紐づくEntityの特徴

Shotgunにデフォルトで用意されているEntityの中で

AssetやShot、TaskなどのEntityは、Projectと紐づける(リンクする)ことを前提に構成されていますそのため、APIで作成する際は、リンク先のProjectの情報も指定する必要があります

※指定しないで作成しようとするとエラーが出ますそれ以外は、前回の記事でProjectを操作した際の方法とほとんど同じ方法で操作出来ます

Shotgun APIでAssetを作成する

今回はAssetを作成してみます

※entity_typeを対応するものに変更すれば、ShotやTaskなどの他のEntityも作成出来ますリンク先のProjectは、前回の記事で作成したSHOTGUN_API_STARTUPとします

Asset作成用スクリプトを作成する

テキストエディタに下記のコードをコピー&ペーストし、shotgun_api_startupフォルダの中に

create_asset.pyという名前で保存しますcreate_asset.py# -*- coding: utf-8 -*- import sys from shotgun import create_shotgun_api from get_project import get_project # 作成するProjectの名称を指定します PROJECT_NAME = "SHOTGUN_API_STARTUP" # 作成するAssetの名称を指定します ASSET_NAME = "SAMPLE_ASSET" def create_asset(shotgun_api, project_info): # ShotgunにAssetを作成します data = {"code": ASSET_NAME, "description": u"このAssetは、Shotgun APIの学習用に作成されました", "project": {"id": project_info.get("id"), "type": project_info.get("type")}} return shotgun_api.create(entity_type="Asset", data=data) def main(): shotgun_api = create_shotgun_api() project_info = get_project(shotgun_api, PROJECT_NAME) print(create_asset(shotgun_api, project_info[0])) return 0 if __name__ == "__main__": sys.exit(main())解説

Shotgun APIを使用するためのオブジェクトの取得やProject情報の取得には、前回の記事(データ操作編・前編)で作成したスクリプトをインポートして使用します

from shotgun import create_shotgun_api from get_project import get_projectAssetの作成に関してもProjectの作成の際に使用した Shotgun APIのcreate 関数を使用します

- Projectを作成する際と異なる点

- create関数に指定しているentity_typeがAssetになっている

- dataにProjectとリンクするために必要な情報を指定している

Projectとリンクするためには、projectフィールドの値として、

対象のProjectのidとtype(entity_type)を指定することでリンクが作成されます# 作成するProjectの名称を指定します PROJECT_NAME = "SHOTGUN_API_STARTUP" # 作成するAssetの名称を指定します ASSET_NAME = "SAMPLE_ASSET" def create_asset(shotgun_api, project_info): # ShotgunにAssetを作成します data = {"code": ASSET_NAME, "description": u"このAssetは、Shotgun APIの学習用に作成されました", "project": {"id": project_info.get("id"), "type": project_info.get("type")}} return shotgun_api.create(entity_type="Asset", data=data)動作確認

動作確認をしている様子を動画にしたのでご覧頂ければと思います

ShotgunAPIでアセットを作成する方法 pic.twitter.com/tveYZQYfb9

— Tetsuya Nozawa (@lphing) January 29, 2020手順

コマンドプロンプトを開いて、下記のコマンドを入力して実行します

※D:\shotgun_api_startupの部分は、自分の環境に合わせて変更して頂ければと思いますcd /d D:\shotgun_api_startup python create_asset.py実行に成功した場合は、下記のような内容が出力されます

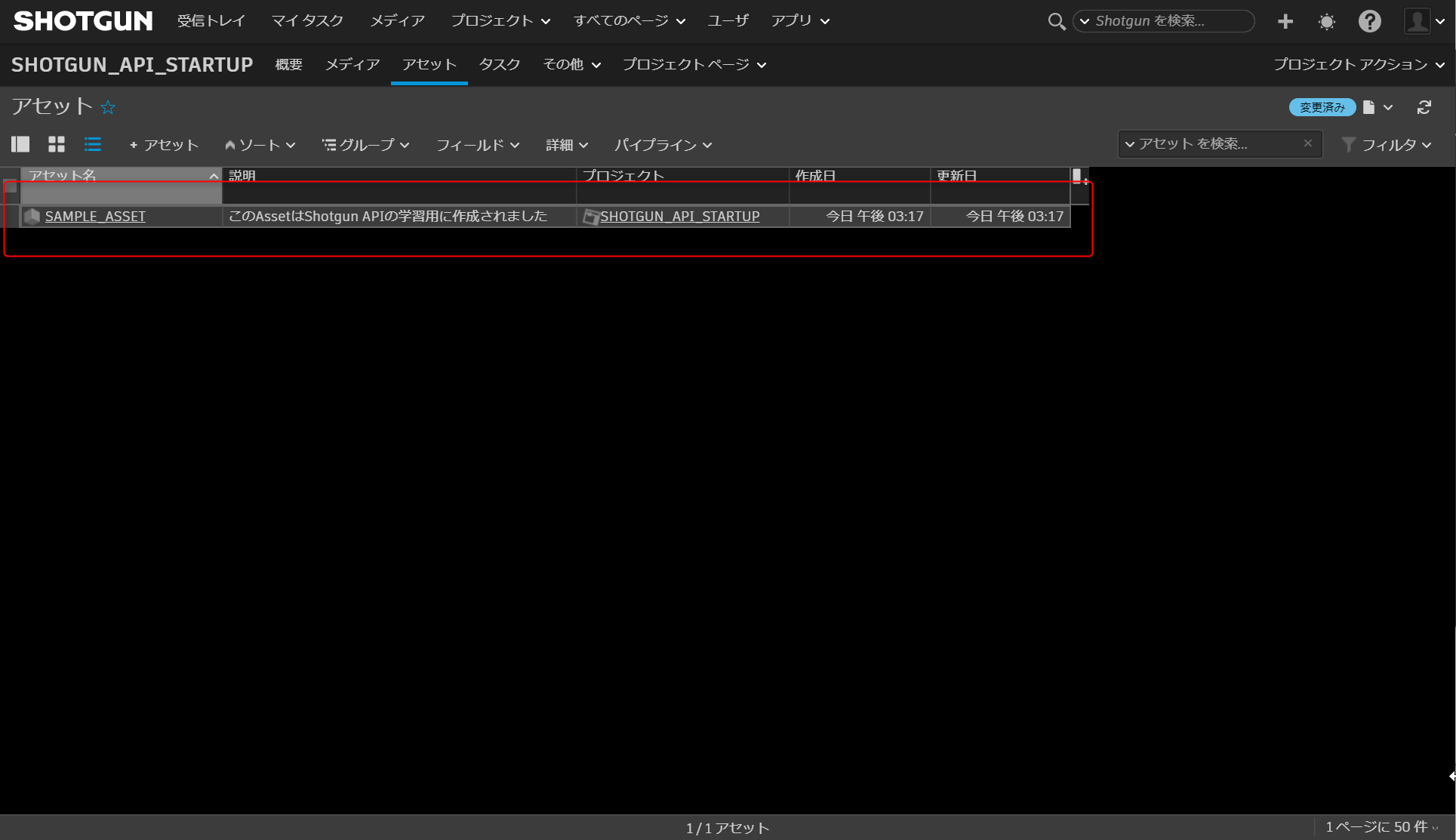

D:\shotgun_api_startup>python create_asset.py {'id': 2292, 'code': 'SAMPLE_ASSET', 'description': 'このAssetはShotgun APIの学習用に作成されました', 'project': {'id': 350, 'name': 'SHOTGUN_API_STARTUP', 'type': 'Project'}, 'type': 'Asset'}ShotgunでAssetテーブルを見てみると、SAMPLE_ASSETという名前のAssetが作成されていることが確認出来るかと思います

Shotgun APIでAssetの取得、更新に関して

Shotgun APIでAssetの取得と更新を行う方法に関しては、

前回の記事のProjectの取得と更新を行う際に作成したスクリプト内の

引数等を少し変更するだけで作成出来てしまいます下記にProjectの取得、更新時に作成したスクリプトをAsset用に変更を加えたものを載せましたので、それぞれテキストエディタにコピー&ペーストして、shotgun_api_startup フォルダに保存して下さい

Assetの取得用スクリプトの作成

下記の内容を get_asset.py という名前で保存します

get_asset.py# -*- coding: utf-8 -*- import sys from shotgun import create_shotgun_api # 取得するAssetの名称を指定します ASSET_NAME = "SAMPLE_ASSET" def get_asset(shotgun_api, asset_name): # codeがasset_nameの値に合致するものを取得対象に設定します filters = [["code", "is", asset_name]] # 取得したい情報が入っているフィールドのフィールドコードを指定します fields = ["code", "description"] # Shotgunからfiltersの条件に合致するAssetの情報を取得します return shotgun_api.find(entity_type="Asset", filters=filters, fields=fields) def main(): shotgun_api = create_shotgun_api() print(get_asset(shotgun_api, ASSET_NAME)) return 0 if __name__ == "__main__": sys.exit(main())

- Projectの取得用スクリプトからの主な変更点

- 取得対象の名称をSAMPLE_ASSETに変更

- entity_typeをAssetに変更

- filtersの値を[["code", "is", asset_name]]に変更

- Assetは名前を入れるためのフィールドがnameでは無くcodeになっているため

- fieldsの値を["code", "description"] に変更

- ProjectとAssetで対応するフィールドのフィールドコードが異なるため

Assetの更新用スクリプトの作成

下記の内容を update_asset.py という名前で保存します

update_asset.py# -*- coding: utf-8 -*- import sys import datetime from shotgun import create_shotgun_api from get_asset import get_asset # 更新対象のAssetの名称を指定します ASSET_NAME = "SAMPLE_ASSET" def update_asset(shotgun_api, asset_info): description = "このデータは、%s に更新されました" % datetime.datetime.now() # Shotgunから取得した情報を使ってdescriptionの内容を更新します return shotgun_api.update(entity_type=asset_info.get("type"), entity_id=asset_info.get("id"), data={"description": description}) def main(): shotgun_api = create_shotgun_api() # Asset情報取得用スクリプトを使って情報を取得します asset_info = get_asset(shotgun_api, ASSET_NAME) print(update_asset(shotgun_api=shotgun_api, asset_info=asset_info[0])) return 0 if __name__ == "__main__": sys.exit(main())

- Projectの更新用スクリプトからの主な変更点

- 更新対象の名称をSAMPLE_ASSETに変更

- update関数の引数dataの値を{"description": description}に変更

- Assetの場合は、説明内容を入れるフィールドのフィールドコードがsg_descriptionでは無くdescriptionとなっているため

取得用・更新用スクリプトの動作確認

動作確認の方法は、前回の記事の「作成したProjectの情報を取得する」と

「Projectの情報を更新(変更)する」を参考にして頂ければと思いますあとがき

今回は、Projectに紐づくEntityの中でAssetのデータ操作方法についてご紹介しました

Asset以外の別のEntityに関しても、今回作成したスクリプト内のentity_typeの値を

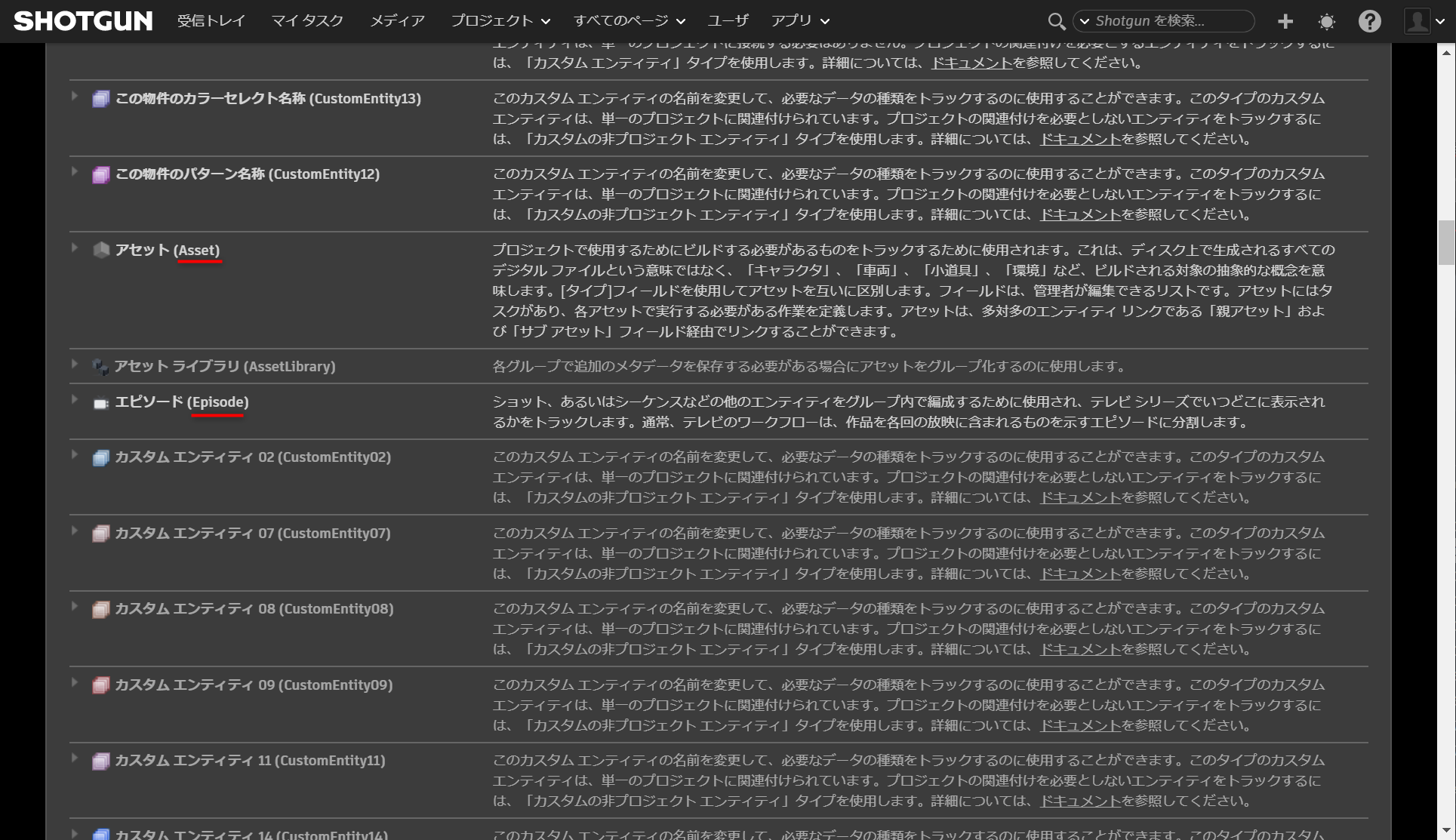

対応するものに変更することで別のEntityのデータ操作用スクリプトも作成出来るかと思いますちなみに各Entityのentity_typeを確認する方法に関しては、

確認方法を動画で撮影しましたので見て頂ければと思いますエンティティタイプの確認方法 pic.twitter.com/Sd2R51cvRR

— Tetsuya Nozawa (@lphing) January 29, 2020手順としては

1. Shotgun右上のプルダウンメニューから サイト基本設定 を選択します

2. エンティティのメニューを開きます

3. entity_typeを確認したいEntityを探します

4. 対象Entityの括弧内の文字がentity_typeです下記の画像の赤線を引いてある箇所がentity_typeです

このページ内で各Entityの詳細設定や新しいEntityの有効化なども出来るようになっています

次回は、ShotgunとSlackを連携して、Shotgunにデータが追加された際にSlackへ通知が飛ぶような仕組みを構築する方法について紹介したいと思います

- 投稿日:2020-01-22T17:56:40+09:00

Shotgun APIを初めて使う方へ - データ操作編・前編 -

前回は、Shotgun APIを使用するための導入部分についての説明を行いました

前回の記事

Shotgun APIを初めて使う方へ - 導入編 -今回は、Shotgun APIを実際に使用してShotgunにデータを登録し、取得や更新等を行っていきたいと思います

前回の記事で作成したフォルダやファイルを使用して進めますので、

まだ前回の記事をご覧になっていない場合は、そちらから先にご覧頂ければ幸いですShotgun APIでProjectを作成する

Shotgunでは、ProjectやAsset、Shotなどの各要素のことをEntityと呼びます

基本的に各Entityは、Project単位で管理が行われる仕組みとなっているため、まずはProjectの作成から入りたいと思いますProject作成用スクリプトの作成

テキストエディタに下記のコードをコピー&ペーストし、前回の記事で作成したshotgun_api_startupフォルダの中に

create_project.pyという名前で保存しますcreate_project.py# -*- coding: utf-8 -*- import sys from shotgun import create_shotgun_api # 作成するProjectの名前を指定します PROJECT_NAME = "SHOTGUN_API_STARTUP" def create_project(shotgun_api): # ShotgunにProjectを作成します data = {"name": PROJECT_NAME, "sg_description": u"このProjectはShotgun APIの学習用に作成しました"} return shotgun_api.create(entity_type="Project", data=data) def main(): shotgun_api = create_shotgun_api() print(create_project(shotgun_api)) return 0 if __name__ == "__main__": sys.exit(main())解説

Shotgunにデータを作成する際は、create 関数を使用します

- 引数

- entity_type

- 指定するentity_typeによってどのEntityを作成するのかが決まります

- data

- 指定した辞書データの内容がProjectの情報として追加されます

- 辞書データ内のnameは必須項目となっていて、作成したいProjectの名前を指定します。名前が重複する場合はエラーが出ます

- 辞書データ内のsg_descriptionは、Projectの説明を指定します

create関数の戻り値には、作成したProjectのidなどの情報が辞書データとして返ってきます

公式ドキュメントの方に詳しい情報が載っています# 作成するProjectの名前を指定します PROJECT_NAME = "SHOTGUN_API_STARTUP" def create_project(shotgun_api): # ShotgunにProjectを作成します data = {"name": PROJECT_NAME, "sg_description": u"このProjectはShotgun APIの学習用に作成しました"} return shotgun_api.create(entity_type="Project", data=data)動作確認

動作確認をしている様子を動画にしたのでご覧頂ければと思います

ShotgunAPIでプロジェクトを作る方法 pic.twitter.com/Ph6jqyYTa4

— Tetsuya Nozawa (@lphing) January 29, 2020手順

コマンドプロンプトを開いて、下記のコマンドを入力して実行します

※D:\shotgun_api_startupの部分は、shotgun_api_startupフォルダを作成した場所に応じて変更して下さいcd /d D:\shotgun_api_startup python create_project.pyProjectの作成に成功した場合は、下記のような内容がコマンドプロンプト上に出力されます

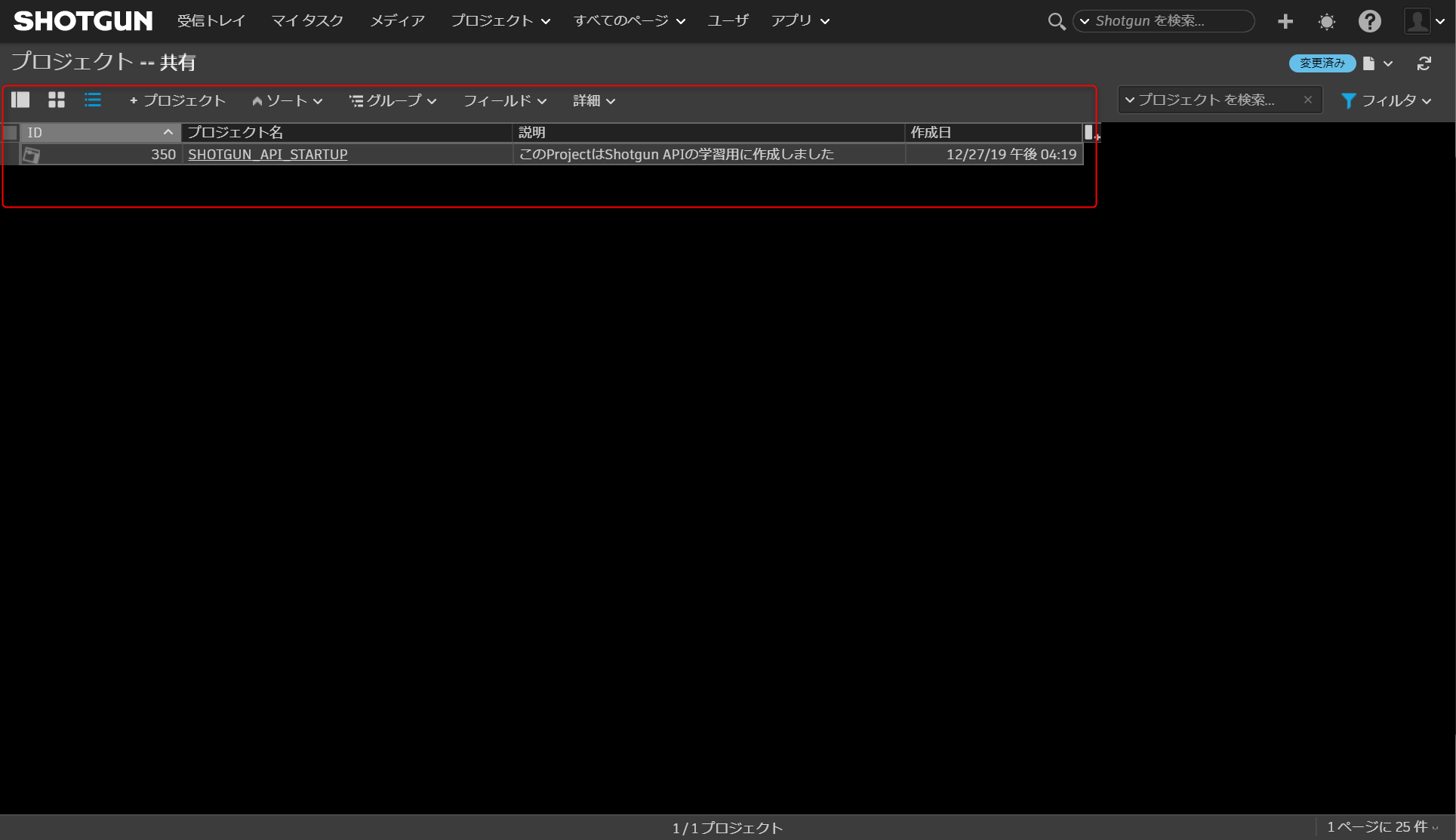

D:\shotgun_api_startup>python create_project.py {'id': 350, 'name': 'SHOTGUN_API_STARTUP', 'sg_description': 'このProjectはShotgun API の学習用に作成しました', 'type': 'Project'}ShotgunでProjectテーブルを見てみると、SHOTGUN_API_STARTUPという名前のProjectが作成されていることが確認出来るかと思います

作成したProjectの情報を取得する

先ほど作成したProjectの情報をAPIで取得してみます

Project取得用スクリプトの作成

テキストエディタに下記のコードをコピー&ペーストし shotgun_api_startupフォルダの中に

get_project.pyという名前で保存しますget_project.py# -*- coding: utf-8 -*- import sys from shotgun import create_shotgun_api # 取得するProjectの名称を指定します PROJECT_NAME = "SHOTGUN_API_STARTUP" def get_project(shotgun_api, project_name): # nameがproject_nameの値に合致するものを取得対象に設定します filters = [["name", "is", project_name]] # 取得したい情報が入っているフィールドのフィールドコードを指定します fields = ["name", "sg_description"] # Shotgunからfiltersの条件に合致するProjectの情報を取得します return shotgun_api.find(entity_type="Project", filters=filters, fields=fields) def main(): shotgun_api = create_shotgun_api() print(get_project(shotgun_api, PROJECT_NAME)) return 0 if __name__ == "__main__": sys.exit(main())解説

Shotgun APIでデータを取得する際は、find 関数を使用します

- 引数

- entity_type

- 指定するentity_typeによって取得するEntityを決めます

- filters

- 取得対象を絞り込むための条件を指定します

- 条件の指定方法に関しては、公式ドキュメントのFilter Syntaxページを参考にして下さい

- fields

- idとtypeに関しては、デフォルトで取得対象となっています

- idとtype以外のフィールドの値も取得する場合は、リストで対象のフィールドのフィールドコードを指定することで対象に含めることが出来ます

- フィールドコードの確認方法については、下記の記事が参考になります

findに関する詳しい情報は 公式ドキュメントに載っています

def get_project(shotgun_api, project_name): # nameがproject_nameの値に合致するものを取得対象に設定します filters = [["name", "is", project_name]] # 取得したい情報が入っているフィールドのフィールドコードを指定します fields = ["name", "sg_description"] # Shotgunからfiltersの条件に合致するProjectの情報を取得します return shotgun_api.find(entity_type="Project", filters=filters, fields=fields)動作確認

コマンドプロンプトを開いて、下記のコマンドを入力して実行します

※D:\shotgun_api_startupの部分は、shotgun_api_startupフォルダを作成した場所に応じて変更して下さいcd /d D:\shotgun_api_startup python get_project.py取得に成功した場合は、下記のような内容がコマンドプロンプト上に出力されます

D:\shotgun_api_startup>python get_project.py [{'type': 'Project', 'id': 350, 'name': 'SHOTGUN_API_STARTUP', 'sg_description': 'このProjectはShotgun APIの学習用に作成しました'}]Projectの情報を更新(変更)する

情報の取得が出来るようになったため、取得したIDを元にProjectの情報を更新したいと思います

※Shotgunに保存されている情報を更新するためには、対象のEntityのIDが必要になりますProject情報の更新用スクリプトを作成する

テキストエディタに下記のコードをコピー&ペーストし、shotgun_api_startupフォルダの中に

update_project.pyという名前で保存しますupdate_project.py# -*- coding: utf-8 -*- import sys import datetime from shotgun import create_shotgun_api from get_project import get_project # 更新対象のProjectの名称を指定します PROJECT_NAME = "SHOTGUN_API_STARTUP" def update_project(shotgun_api, project_info): description = "このデータは、%s に更新されました" % datetime.datetime.now() # Shotgunから取得した情報を使ってsg_descriptionの内容を更新します return shotgun_api.update(entity_type=project_info.get("type"), entity_id=project_info.get("id"), data={"sg_description": description}) def main(): shotgun_api = create_shotgun_api() # Project情報取得用スクリプトを使って情報を取得します project_info = get_project(shotgun_api, PROJECT_NAME) print(update_project(shotgun_api=shotgun_api, project_info=project_info[0])) return 0 if __name__ == "__main__": sys.exit(main())解説

Shotgun APIでデータを更新する場合は、update 関数を使用します

- 引数

- entity_type

- 更新対象のEntityのtypeを指定します

- entity_id

- 更新対象のEntityのIDを指定します

- data

- 更新する内容を辞書型で指定します

- 今回の場合は、sg_descriptionの値が更新されます

def update_project(shotgun_api, project_info): description = "このデータは、%s に更新されました" % datetime.datetime.now() # Shotgunから取得した情報を使ってsg_descriptionの内容を更新します return shotgun_api.update(entity_type=project_info.get("type"), entity_id=project_info.get("id"), data={"sg_description": description})動作確認

動作確認をしている様子を動画にしたのでご覧頂ければと思います

ShotgunAPIでプロジェクトの情報を取得・更する方法 pic.twitter.com/vwEI90oJcQ

— Tetsuya Nozawa (@lphing) January 29, 2020手順

コマンドプロンプトを開いて、下記のコマンドを入力して実行します

※D:\shotgun_api_startupの部分は、自分の環境に合わせて変更して頂ければと思いますcd /d D:\shotgun_api_startup python update_project.py実行に成功した場合は、下記のような内容が出力されます

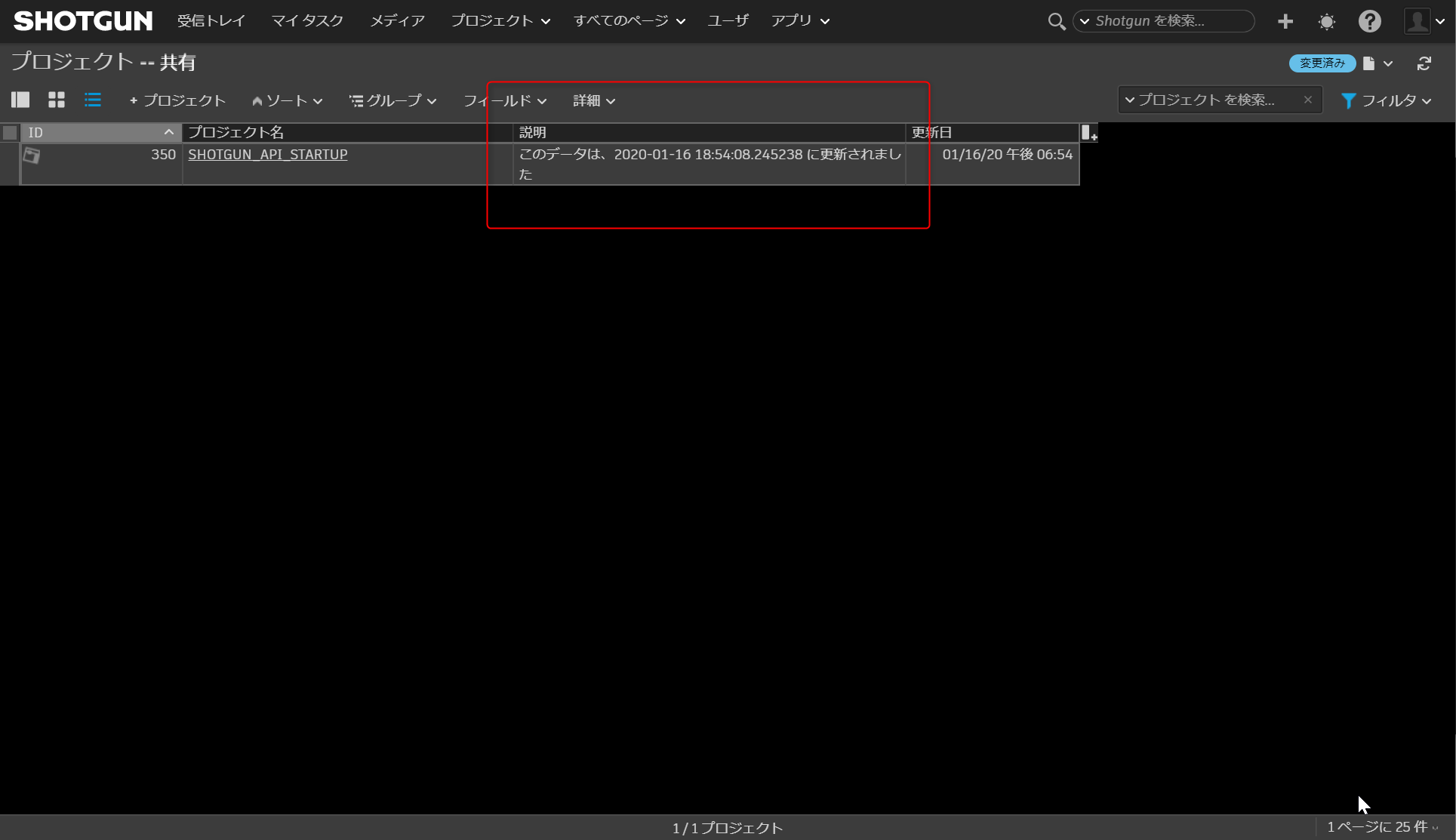

D:\shotgun_api_startup>python update_project.py {'type': 'Project', 'id': 350, 'sg_description': 'このデータは、2020-01-16 16:43:13.293248 に更新されました'}ShotgunでProjectテーブルを見てみると、SHOTGUN_API_STARTUPのdescriptionフィールドの値が更新

されていることが確認出来るかと思います

あとがき

ここまで紹介した内容で、Shotgun APIを使用した基本的なデータ操作が出来るようになったかと思います

次回の後編では、AssetやShot、TaskなどProjectに紐づくEntityの作成方法を紹介します

- 投稿日:2020-01-22T17:55:49+09:00

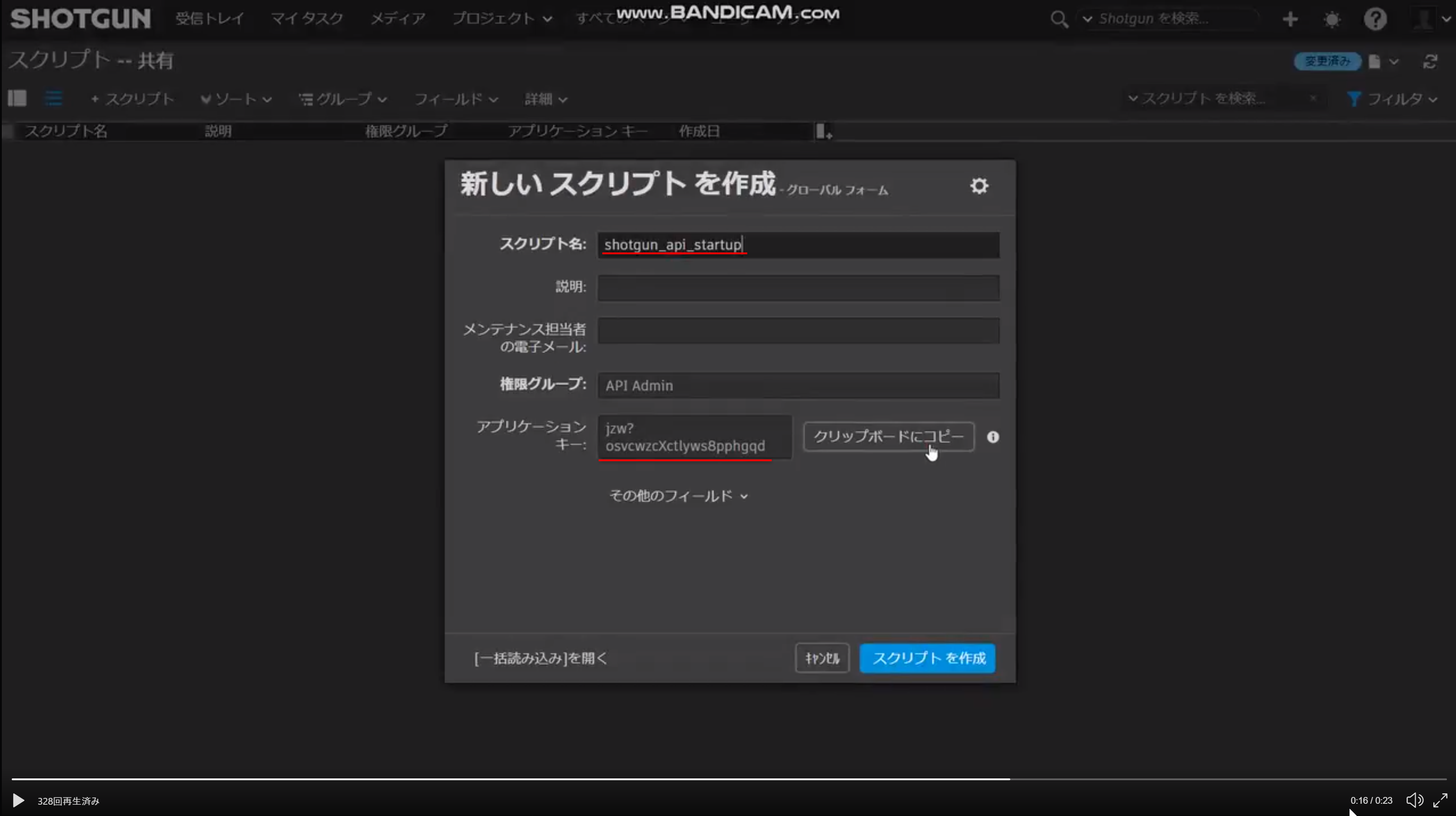

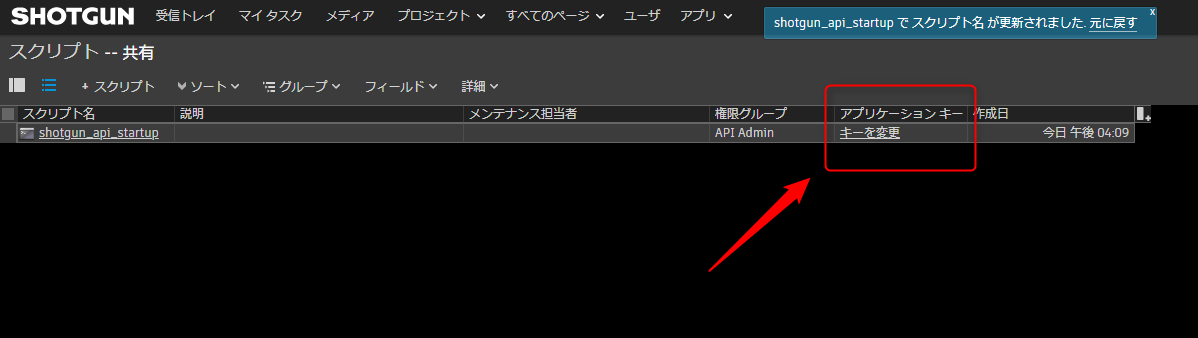

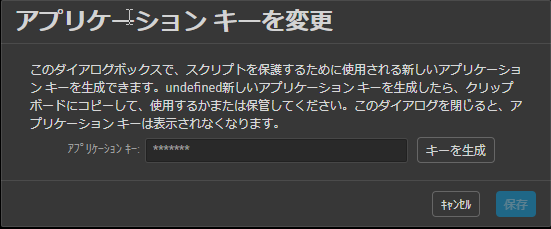

Shotgun APIを初めて使う方へ - 導入編 -

Shotgun APIを初めて使用する方に向けた記事をこれから書いていきたいと思っています

今回は、導入編ということでAPIを使うための導入手順について解説します

開発環境

- OS: Windows 10 Pro

- Python 3.6.8

- git 2.23.0

- テキストエディタ

- Visual Studio Code

Pythonをインストール

Python2 は2020年1月1日でサポート終了とのことですので

Python3をインストールして頂ければと思います下記のページが参考になります

Python3のインストールgitをインストール

Shotgun APIをインストールする際に必要なためインストールします

下記のページが参考になります

gitのインストールと起動方法Shotgun APIのインストール

Shotgun APIの公式ドキュメントの installation を見るといくつか方法が書かれています

pythonのpipコマンドを使用することでPYTHONPATHが通った場所にインストールすることが出来るため、

こちらを使用してインストールを行います下記のコマンドを実行します

pip install git+git://github.com/shotgunsoftware/python-api.gitインストールが完了すると下記のようなメッセージが表示されます

Successfully installed shotgun-api3-3.2.2下記のコマンドでインストールされているパッケージのリストを確認します

pip listshotgun_api3があれば問題無くインストールされています