- 投稿日:2020-11-30T23:57:40+09:00

Nornir 3.0の注意点とNETCONF 経由で、Cisco IOS XE ホスト名の取得

はじめに

この記事はシスコの同志による Advent Calendar の一部として投稿しています

- 2017年版: https://qiita.com/advent-calendar/2017/cisco

- 2018年版: https://qiita.com/advent-calendar/2018/cisco

- 2019年版: https://qiita.com/advent-calendar/2019/cisco

- 2020年版: https://qiita.com/advent-calendar/2020/cisco (今ここ)Nornir

NornirとはPython製自動化フレームワークのことでAnsibleなどに近いものになっています。

今回のブログでは3.0を動かす注意点とNETCONFでhost名を取得するコードについて書きます接続方法

- Netmiko

- NAPALM

- NETCONFNornir3.0から2.0の時より大きく変わって過去のプログラミングのソースコードが使えなくなる部分が多く

注意点が多くなっています。

特に個別でpluginをインストールする必要が出たりします。pluginを理解しないとサンプルコードを書くことも出来ないです。Nornirでよく出るエラーの例を出します。

ModuleNotFoundError: No module named 'nornir.plugins.tasks.networking'2020.09.01バージョンだとエラーは出ないのですが最新の3.0ではエラーが出ます。何も考えないで過去のコードや公式Docのチュートリアルはモジュールないよのエラーで埋め尽くされることでしょう

自分が入れてエラーが出なくなったモジュールをいくつか紹介します。

~ (nornir) KATSHIMA:gg katshima$ pip install nornir ~ (nornir) KATSHIMA:gg katshima$ pip install nornir_napalm ~ (nornir) KATSHIMA:gg katshima$ pip install nornir_netmiko ~ (nornir) KATSHIMA:gg katshima$ pip install nornir_netbox ~ (nornir) KATSHIMA:gg katshima$ pip install nornir_ansible ~ (nornir) KATSHIMA:gg katshima$ pip install nornir_scrapli ~ (nornir) KATSHIMA:gg katshima$ pip install nornir_utils ~ (nornir) KATSHIMA:gg katshima$ pip install nornir_jinja2上記のModuleNotFoundErrorはnornir_scrapliで解消されたのでnornir_scrapliは必須なのかなと思ってます

以上のモジュールは入れておかないとまともに動かない感じあります。

残りのプラグイン等は以下のページにdescriptionと共に書かれているので参考にすると良いと思います。

https://nornir.tech/nornir/plugins/ホスト名を取得する

環境

環境

Cisco IOS-XE (16.11)

Cisco DevNet SandBox

Python 3.7.4

nornir 3.0.0aこのブログのすべての例では、Cisco Devnetが提供するCisco SandBox環境を使用します。Devnetを見に行きましょう。主にIOS XEのSandBoxを使用しています。自動化を試験するときにわざわざ機材を準備しなくていいので本当に楽です。

config.yml inventory/hosts.yml inventory/groups.yml inventory/defaults.ymlconfig.yaml

--- runners: plugin: threaded options: num_workers: 10 inventory: plugin: "SimpleInventory" options: host_file: "./inventory/hosts.yml" group_file: "./inventory/groups.yml" defaults_file: "./inventory/defaults.yml"hosts.yaml

--- DEV01: hostname: ios-xe-mgmt.cisco.com groups: - Devnet DEV02: hostname: ios-xe-mgmt-latest.cisco.com groups: - Devnetdefault.yml

--- platform: ios port: 8181 username: "developer" password: "C1sco12345"groups.yml

--- Devnet: data: ntp: servers: - 1.1.1.1hostget.py

from nornir import InitNornir from nornir_utils.plugins.functions import print_result nornir = InitNornir('nornir_config.yml') print(nornir.inventory.hosts) r1 = nornir.inventory.hosts['DEV01'] print(f"Group: {r1.groups}") print(f"Hostname: {r1.hostname}") print(f"Username: {r1.username}") print(f"Password: {r1.password}")実行結果

(nornir) KATSHIMA-M-J6EA:non katshima$ python aa.py {'DEV01': Host: DEV01, 'DEV02': Host: DEV02} Group: [Group: Devnet] Hostname: ios-xe-mgmt.cisco.com Username: None Password: None感想

2日間粘ってようやく動きました。

まだまだドキュメントが充実していないのでまだまだこれからの自動化フレームワークな気がしますが

いろんな接続方法を簡単に指定できるのはとても魅力的だと思います。次回はいろんな機器の状態を持ってくるコードを紹介しようと思います。

コードはGithubにもあげます。よかったらフォローしてください

https://github.com/Katsuya414参考記事

https://tekunabe.hatenablog.jp/entry/2020/06/14/nornir_netconf_get

https://nornir.readthedocs.io/en/latest/plugins/index.html

https://blog.wimwauters.com/networkprogrammability/2020-09-29_nornir3.0_introduction/

https://github.com/wiwa1978/blog-hugo-netlify-code/tree/master/Nornir_Introduction

- 投稿日:2020-11-30T23:57:40+09:00

Nornir 3.0の注意点とCisco IOS XE ホスト名の取得

はじめに

この記事はシスコの同志による Advent Calendar の一部として投稿しています

- 2017年版: https://qiita.com/advent-calendar/2017/cisco

- 2018年版: https://qiita.com/advent-calendar/2018/cisco

- 2019年版: https://qiita.com/advent-calendar/2019/cisco

- 2020年版: https://qiita.com/advent-calendar/2020/cisco (今ここ)Nornir

NornirとはPython製自動化フレームワークのことでAnsibleなどに近いものになっています。

今回のブログでは3.0を動かす注意点とNETCONFでhost名を取得するコードについて書きます接続方法

- Netmiko

- NAPALM

- NETCONFNornir3.0から2.0の時より大きく変わって過去のプログラミングのソースコードが使えなくなる部分が多く

注意点が多くなっています。

特に個別でpluginをインストールする必要が出たりします。pluginを理解しないとサンプルコードを書くことも出来ないです。Nornirでよく出るエラーの例を出します。

ModuleNotFoundError: No module named 'nornir.plugins.tasks.networking'2020.09.01バージョンだとエラーは出ないのですが最新の3.0ではエラーが出ます。何も考えないで過去のコードや公式Docのチュートリアルはモジュールないよのエラーで埋め尽くされることでしょう

自分が入れてエラーが出なくなったモジュールをいくつか紹介します。

~ (nornir) KATSHIMA:gg katshima$ pip install nornir ~ (nornir) KATSHIMA:gg katshima$ pip install nornir_napalm ~ (nornir) KATSHIMA:gg katshima$ pip install nornir_netmiko ~ (nornir) KATSHIMA:gg katshima$ pip install nornir_netbox ~ (nornir) KATSHIMA:gg katshima$ pip install nornir_ansible ~ (nornir) KATSHIMA:gg katshima$ pip install nornir_scrapli ~ (nornir) KATSHIMA:gg katshima$ pip install nornir_utils ~ (nornir) KATSHIMA:gg katshima$ pip install nornir_jinja2上記のModuleNotFoundErrorはnornir_scrapliで解消されたのでnornir_scrapliは必須なのかなと思ってます

以上のモジュールは入れておかないとまともに動かない感じあります。

残りのプラグイン等は以下のページにdescriptionと共に書かれているので参考にすると良いと思います。

https://nornir.tech/nornir/plugins/ホスト名を取得する

環境

環境

Cisco IOS-XE (16.11)

Cisco DevNet SandBox

Python 3.7.4

nornir 3.0.0aこのブログのすべての例では、Cisco Devnetが提供するCisco SandBox環境を使用します。Devnetを見に行きましょう。主にIOS XEのSandBoxを使用しています。自動化を試験するときにわざわざ機材を準備しなくていいので本当に楽です。

config.yml inventory/hosts.yml inventory/groups.yml inventory/defaults.ymlconfig.yaml

--- runners: plugin: threaded options: num_workers: 10 inventory: plugin: "SimpleInventory" options: host_file: "./inventory/hosts.yml" group_file: "./inventory/groups.yml" defaults_file: "./inventory/defaults.yml"hosts.yaml

--- DEV01: hostname: ios-xe-mgmt.cisco.com groups: - Devnet DEV02: hostname: ios-xe-mgmt-latest.cisco.com groups: - Devnetdefault.yml

--- platform: ios port: 8181 username: "developer" password: "C1sco12345"groups.yml

--- Devnet: data: ntp: servers: - 1.1.1.1hostget.py

from nornir import InitNornir from nornir_utils.plugins.functions import print_result nornir = InitNornir('nornir_config.yml') print(nornir.inventory.hosts) r1 = nornir.inventory.hosts['DEV01'] print(f"Group: {r1.groups}") print(f"Hostname: {r1.hostname}") print(f"Username: {r1.username}") print(f"Password: {r1.password}")実行結果

(nornir) KATSHIMA-M-J6EA:non katshima$ python aa.py {'DEV01': Host: DEV01, 'DEV02': Host: DEV02} Group: [Group: Devnet] Hostname: ios-xe-mgmt.cisco.com Username: None Password: None感想

2日間粘ってようやく動きました。

まだまだドキュメントが充実していないのでまだまだこれからの自動化フレームワークな気がしますが

いろんな接続方法を簡単に指定できるのはとても魅力的だと思います。次回はいろんな機器の状態を持ってくるコードを紹介しようと思います。

コードはGithubにもあげます。よかったらフォローしてください

https://github.com/Katsuya414参考記事

https://tekunabe.hatenablog.jp/entry/2020/06/14/nornir_netconf_get

https://nornir.readthedocs.io/en/latest/plugins/index.html

https://blog.wimwauters.com/networkprogrammability/2020-09-29_nornir3.0_introduction/

https://github.com/wiwa1978/blog-hugo-netlify-code/tree/master/Nornir_Introduction

- 投稿日:2020-11-30T23:25:11+09:00

和文テキストから主語・動詞(述語)・目的語のSVO(SPO)Triple setを抽出する関数

作ったもの

( get_svo_triple.py )

( 文を1個、parseする例 )

Python3.9.0>>> from get_svo_triple import * >>> >>> sentence = "ムスカさんは昨日、ジェラート屋さんでアフォガードをたくさんた食べた。" >>> (result1, result2) = return_svo_triple(sentence) >>> >>> print(result1) {'主語': 'ムスカさんは', '述語': '食べた。'} >>> >>> print(result2) ['ムスカさんは->食べた。', 'たくさんた->食べた。'] >>>Python3.9.0>>> sentence = "ムスカさんは昨日、アフォガードをたくさん食べた。" >>> (result1, result2) = return_svo_triple(sentence) >>> >>> print(result1) {'主語': 'ムスカさんは', '目的語': 'アフォガードを', '述語': '食べた。'} >>> >>> print(result2) ['ムスカさんは->食べた。', '昨日、->食べた。', 'アフォガードを->食べた。', 'たくさん->食べた。'] >>>Python3.9.0>>> sentence = "ムスカさんは昨日、赤い屋根のジェラート屋さんでアフォガードをたくさん食べた。" >>> (result1, result2) = return_svo_triple(sentence) >>> >>> print(result1) {'主語': 'ムスカさんは', '目的語': 'アフォガードを', '述語': '食べた。'} >>> >>> print(result2) ['ムスカさんは->食べた。', '昨日、->食べた。', 'ジェラート屋さんで->食べた。', 'アフォガードを->食べた。', 'たくさん->食べた。'] >>>Python3.9.0>>> sentence = "ムスカさんはおとといと昨日、赤い屋根のジェラート屋さんで、アフォガードをたくさん食べた。" >>> (result1, result2) = return_svo_triple(sentence) >>> >>> print(result1) {'目的語': 'アフォガードを', '述語': '食べた。'} >>> >>> print(result2) ['ジェラート屋さんで、->食べた。', 'アフォガードを->食べた。', 'たくさん->食べた。'] >>>Python3.9.0>>> sentence = "ムスカさんはおとといと昨日、赤い屋根のジェラート屋さんでアフォガードをたくさん食べた。" >>> (result1, result2) = return_svo_triple(sentence) >>> >>> print(result1) {'主語': 'ムスカさんは', '目的語': 'アフォガードを', '述語': '食べた。'} >>> >>> print(result2) ['ムスカさんは->食べた。', '昨日、->食べた。', 'ジェラート屋さんで->食べた。', 'アフォガードを->食べた。', 'たくさん->食べた。'] >>>( 文を複数件、parseする例 )

(サンプルテキストの出典)

・ NHK NewsWeb(国際面)2020年11月30日 22時03分付配信記事

Python3.9.0>>> sentence1 = "イランで核科学者が何者かに銃撃されて死亡した事件で、地元の国営テレビは関係者の話として、殺害に使用された武器はイスラエル製だと伝えました。" >>> sentence2 = "この事件について、国営テレビの英語チャンネルは、30日、関係者の話として「現場で回収された武器にはイスラエルの軍事産業につながる特徴があり、イスラエル製の武器が使われていた」と伝えました。" >>> >>> >>> result_list = [return_svo_triple(sentence) for sentence in [sentence1, sentence2]] >>> >>> from pprint import pprint >>> >>> pprint(result_list) [({'主語': '武器は', '目的語': 'イスラエル製だと', '述語': '伝えました。'}, ['事件で、->伝えました。', '国営テレビは->伝えました。', '話として、->伝えました。', '武器は->伝えました。', 'イスラエル製だと->伝えました。']), ({'主語': '英語チャンネルは、', '目的語': '使われていた」と', '述語': '伝えました。'}, ['事件について、->伝えました。', '英語チャンネルは、->伝えました。', '30日、->伝えました。', '話として->伝えました。', '使われていた」と->伝えました。'])] >>>( ニュース記事の全文を処理する場合 )

Python3.9.0>>> document = """ ... イランで核科学者が何者かに銃撃されて死亡した事件で、地元の国営テレビは関係者の話として、殺害に使用された武器はイスラエル製だと伝えました。イランの国防軍需相は「暗殺に対しては必ずやり返す」と改めて報復を警告しています。 ... ... イラン政府によりますと、27日、国防軍需省の研究開発部門トップで、核開発技術を研究していたファクリザデ氏が何者かに銃撃されて死亡しました。 ... ... この事件について、国営テレビの英語チャンネルは、30日、関係者の話として「現場で回収された武器にはイスラエルの軍事産業につながる特徴があり、イスラエル製の武器が使われていた」と伝えました。 ... ... また、国営テレビのアラビア語チャンネルも「衛星を通じて、操作されたイスラエル製の武器が使われた」と伝えています。 ... ... 一方、保守系のファルス通信は、現場に実行犯の姿はなく、遠隔操作で作動する機関銃が使われた可能性があると伝えています。 ... ... この事件について30日、イスラエルの諜報相は地元のラジオ番組で「誰がやったのかは知らない」とコメントしています。 ... ... イランの首都テヘランで30日、ファクリザデ氏の葬儀が営まれ、参列したハタミ国防軍需相は「イラン国民の暗殺に対しては必ずやり返す。犯罪を企て、実行したものたちに罰を与える」と述べ、改めて報復を警告しています。""" >>> >>> document = document.replace(" ", "").replace(" ", "").replace("\n", "") >>> sentence_list = document.split("。") >>> pprint(len(sentence_list)) 10 >>> sentence_list = [sentence for sentence in sentence_list if not(sentence == "")] >>> pprint(sentence_list) ['イランで核科学者が何者かに銃撃されて死亡した事件で、地元の国営テレビは関係者の話として、殺害に使用された武器はイスラエル製だと伝えました', 'イランの国防軍需相は「暗殺に対しては必ずやり返す」と改めて報復を警告しています', 'イラン政府によりますと、27日、国防軍需省の研究開発部門トップで、核開発技術を研究していたファクリザデ氏が何者かに銃撃されて死亡しました', 'この事件について、国営テレビの英語チャンネルは、30日、関係者の話として「現場で回収された武器にはイスラエルの軍事産業につながる特徴があり、イスラエル製の武器が使われていた」と伝えました', 'また、国営テレビのアラビア語チャンネルも「衛星を通じて、操作されたイスラエル製の武器が使われた」と伝えています', '一方、保守系のファルス通信は、現場に実行犯の姿はなく、遠隔操作で作動する機関銃が使われた可能性があると伝えています', 'この事件について30日、イスラエルの諜報相は地元のラジオ番組で「誰がやったのかは知らない」とコメントしています', 'イランの首都テヘランで30日、ファクリザデ氏の葬儀が営まれ、参列したハタミ国防軍需相は「イラン国民の暗殺に対しては必ずやり返す', '犯罪を企て、実行したものたちに罰を与える」と述べ、改めて報復を警告しています'] >>> >>> result_list = [return_svo_triple(sentence) for sentence in sentence_list] >>> pprint(result_list) [({'主語': '武器は', '目的語': 'イスラエル製だと', '述語': '伝えました'}, ['事件で、->伝えました', '国営テレビは->伝えました', '話として、->伝えました', '武器は->伝えました', 'イスラエル製だと->伝えました']), ({'主語': '国防軍需相は', '目的語': '報復を', '述語': '警告しています'}, ['国防軍需相は->警告しています', 'やり返す」と->警告しています', '改めて->警告しています', '報復を->警告しています']), ({'述語': '死亡しました'}, ['よりますと、->死亡しました', '27日、->死亡しました', '銃撃されて->死亡しました']), ({'主語': '英語チャンネルは、', '目的語': '使われていた」と', '述語': '伝えました'}, ['事件について、->伝えました', '英語チャンネルは、->伝えました', '30日、->伝えました', '話として->伝えました', '使われていた」と->伝えました']), ({'主語': 'アラビア語チャンネルも', '目的語': '使われた」と', '述語': '伝えています'}, ['また、->伝えています', 'アラビア語チャンネルも->伝えています', '使われた」と->伝えています']), ({'目的語': 'あると', '述語': '伝えています'}, ['一方、->伝えています', 'あると->伝えています']), ({'主語': '諜報相は', '目的語': '知らない」と', '述語': 'コメントしています'}, ['事件について->コメントしています', '30日、->コメントしています', '諜報相は->コメントしています', 'ラジオ番組で->コメントしています', '知らない」と->コメントしています']), ({'主語': '暗殺に対しては', '目的語': '暗殺に対しては', '述語': 'やり返す'}, ['営まれ、->やり返す', 'ハタミ国防軍需相は->やり返す', '暗殺に対しては->やり返す', '必ず->やり返す']), ({'目的語': '報復を', '述語': '警告しています'}, ['述べ、->警告しています', '改めて->警告しています', '報復を->警告しています'])] >>>問題意識

係り受け解析器を用いて、テキストデータから、SVO(SPO)のTriple set([主語, 動詞(述語), 目的語])を返す処理を行う実装コードを探してみたところ、なかなか見当たりませんでした。

そのため、備忘録まで、この記事を立ててみました。

時間をかけて方々を探してみたところ、見つけた以下のコードがうまく動きました。

・ 東邦大学 「2014-01-29 CaboChaによる係り受け解析の利用 ~ 文の主節の骨組を取り出す 」

東邦大学の研究室が公開中のコードを、以下の関数(メソッド)に書き換えてみました。

定義した関数(メソッド)のInput->Outputの入出力仕様・引数と返り値: str -> Tuple[Dict, List] ・引数に渡せるのは、1つの文(sentence)だけです。 ・引数に渡すstr型のデータは、分かち書きにする必要はありません。平文のまま渡します。東邦大学のコードを関数(メソッド)で包んだスクリプト

get_svo_triple.pyimport CaboCha import sys import codecs # https://docs.python.org/ja/3.6/library/typing.html from typing import Dict, Tuple, List def return_svo_triple(sentence:str) -> Tuple[Dict, List]: c = CaboCha.Parser() tree = c.parse(sentence) size = tree.size() myid = 0 ku_list = [] ku = '' ku_id = 0 ku_link = 0 kakari_joshi = 0 kaku_joshi = 0 for i in range(0, size): token = tree.token(i) if token.chunk: if (ku!=''): ku_list.append((ku, ku_id, ku_link, kakari_joshi, kaku_joshi)) #前 の句をリストに追加 kakari_joshi = 0 kaku_joshi = 0 ku = token.normalized_surface ku_id = myid ku_link = token.chunk.link myid=myid+1 else: ku = ku + token.normalized_surface m = (token.feature).split(',') if (m[1] == u'係助詞'): kakari_joshi = 1 if (m[1] == u'格助詞'): kaku_joshi = 1 ku_list.append((ku, ku_id, ku_link, kakari_joshi, kaku_joshi)) # 最後にも前の句をリストに追加 for k in ku_list: if (k[2]==-1): # link==-1? # 述語である jutsugo_id = ku_id # この時のidを覚えておく #述語句 predicate_word = [k[0] for k in ku_list if (k[1]==jutsugo_id)] #for k in ku_list: # if (k[1]==jutsugo_id): # jutsugo_idと同じidを持つ句を探す # print(k[1], k[0], k[2], k[3], k[4]) #述語句に係る句 # jutsugo_idと同じidをリンク先に持つ句を探す word_to_predicate_list = [k[0] for k in ku_list if k[2]==jutsugo_id] # 述語句に係る句 -> 述語句 svo_arrow_text = [str(word_to_predicate) + "->" + str(predicate_word[0]) for word_to_predicate in word_to_predicate_list] #print(svo_arrow_text) svo_dict = {} for num, k in enumerate(ku_list): if (k[2]==jutsugo_id): # jutsugo_idと同じidをリンク先に持つ句を探す if (k[3] == 1): subject_word = k[0] svo_dict["主語"] = subject_word #print(subject_word) if (k[4] == 1): object_word = k[0] svo_dict["目的語"] = object_word #print(object_word) if (k[1] == jutsugo_id): predicate_word = k[0] svo_dict["述語"] = predicate_word #print(predicate_word) return (svo_dict, svo_arrow_text)今後やりたいこと

<1つ目>

・ 以下の論文ほかを参考に、Web空間上のテキストデータから、出来事間の時系列因果構造を抽出したい。

・ さらに、獲得した出来事間の時系列因果構造を、視覚的に把握しやすいように、グラフ構造のネットワーク図に描画したい。・ 石井ほか 「SVO構造を用いた因果関係ネットワーク構築手法について」

<2つ目>

・[主語 -> 述語(動詞など) -> 目的語・補語]の三つ組データ(Triple set)を、Prologなどの論理推論ができるプログラミング言語に与えることで、複数の三つ組データ(Triple set)間の因果関係や概念意味関係を用いた知識推論を行ってみたい。

<3つ目>

・ MaskedTransformerやVideoBERTなどの学習済みモデルを用いて、静止画像や動画の内容説明文(内容要約文、キャプション文)を生成し、その説明文に含まれる[主語 -> 述語(動詞など) -> 目的語・補語]の三つ組データ(Triple set)を抽出したい。

・ 動画の説明文から抜き出した「主語」や「目的語」や「補語」の単語を、DB(データベース)に格納して、固有表現抽出器(Named Entitity Recogniton)を用いて、「人名」や「組織名」や「地名」といった固有表現ラベルを紐付けたい。

・ その結果、特定の人物や組織や地名が登場する静止画や動画を、容易に検索できるプラットフォームを構築したい。

- 投稿日:2020-11-30T23:25:11+09:00

和文から主語・動詞(述語)・目的語のSVO(SPO)Triple setを抽出する関数

作ったもの

( get_svo_triple.py )

( 文を1個、parseする例 )

Python3.9.0>>> from get_svo_triple import * >>> >>> sentence = "ムスカさんは昨日、ジェラート屋さんでアフォガードをたくさんた食べた。" >>> (result1, result2) = return_svo_triple(sentence) >>> >>> print(result1) {'主語': 'ムスカさんは', '述語': '食べた。'} >>> >>> print(result2) ['ムスカさんは->食べた。', 'たくさんた->食べた。'] >>>Python3.9.0>>> sentence = "ムスカさんは昨日、アフォガードをたくさん食べた。" >>> (result1, result2) = return_svo_triple(sentence) >>> >>> print(result1) {'主語': 'ムスカさんは', '目的語': 'アフォガードを', '述語': '食べた。'} >>> >>> print(result2) ['ムスカさんは->食べた。', '昨日、->食べた。', 'アフォガードを->食べた。', 'たくさん->食べた。'] >>>Python3.9.0>>> sentence = "ムスカさんは昨日、赤い屋根のジェラート屋さんでアフォガードをたくさん食べた。" >>> (result1, result2) = return_svo_triple(sentence) >>> >>> print(result1) {'主語': 'ムスカさんは', '目的語': 'アフォガードを', '述語': '食べた。'} >>> >>> print(result2) ['ムスカさんは->食べた。', '昨日、->食べた。', 'ジェラート屋さんで->食べた。', 'アフォガードを->食べた。', 'たくさん->食べた。'] >>>Python3.9.0>>> sentence = "ムスカさんはおとといと昨日、赤い屋根のジェラート屋さんで、アフォガードをたくさん食べた。" >>> (result1, result2) = return_svo_triple(sentence) >>> >>> print(result1) {'目的語': 'アフォガードを', '述語': '食べた。'} >>> >>> print(result2) ['ジェラート屋さんで、->食べた。', 'アフォガードを->食べた。', 'たくさん->食べた。'] >>>Python3.9.0>>> sentence = "ムスカさんはおとといと昨日、赤い屋根のジェラート屋さんでアフォガードをたくさん食べた。" >>> (result1, result2) = return_svo_triple(sentence) >>> >>> print(result1) {'主語': 'ムスカさんは', '目的語': 'アフォガードを', '述語': '食べた。'} >>> >>> print(result2) ['ムスカさんは->食べた。', '昨日、->食べた。', 'ジェラート屋さんで->食べた。', 'アフォガードを->食べた。', 'たくさん->食べた。'] >>>( 文を複数件、parseする例 )

(サンプルテキストの出典)

・ NHK NewsWeb(国際面)2020年11月30日 22時03分付配信記事

Python3.9.0>>> sentence1 = "イランで核科学者が何者かに銃撃されて死亡した事件で、地元の国営テレビは関係者の話として、殺害に使用された武器はイスラエル製だと伝えました。" >>> sentence2 = "この事件について、国営テレビの英語チャンネルは、30日、関係者の話として「現場で回収された武器にはイスラエルの軍事産業につながる特徴があり、イスラエル製の武器が使われていた」と伝えました。" >>> >>> >>> result_list = [return_svo_triple(sentence) for sentence in [sentence1, sentence2]] >>> >>> from pprint import pprint >>> >>> pprint(result_list) [({'主語': '武器は', '目的語': 'イスラエル製だと', '述語': '伝えました。'}, ['事件で、->伝えました。', '国営テレビは->伝えました。', '話として、->伝えました。', '武器は->伝えました。', 'イスラエル製だと->伝えました。']), ({'主語': '英語チャンネルは、', '目的語': '使われていた」と', '述語': '伝えました。'}, ['事件について、->伝えました。', '英語チャンネルは、->伝えました。', '30日、->伝えました。', '話として->伝えました。', '使われていた」と->伝えました。'])] >>>( ニュース記事の全文を処理する場合 )

Python3.9.0>>> document = """ ... イランで核科学者が何者かに銃撃されて死亡した事件で、地元の国営テレビは関係者の話として、殺害に使用された武器はイスラエル製だと伝えました。イランの国防軍需相は「暗殺に対しては必ずやり返す」と改めて報復を警告しています。 ... ... イラン政府によりますと、27日、国防軍需省の研究開発部門トップで、核開発技術を研究していたファクリザデ氏が何者かに銃撃されて死亡しました。 ... ... この事件について、国営テレビの英語チャンネルは、30日、関係者の話として「現場で回収された武器にはイスラエルの軍事産業につながる特徴があり、イスラエル製の武器が使われていた」と伝えました。 ... ... また、国営テレビのアラビア語チャンネルも「衛星を通じて、操作されたイスラエル製の武器が使われた」と伝えています。 ... ... 一方、保守系のファルス通信は、現場に実行犯の姿はなく、遠隔操作で作動する機関銃が使われた可能性があると伝えています。 ... ... この事件について30日、イスラエルの諜報相は地元のラジオ番組で「誰がやったのかは知らない」とコメントしています。 ... ... イランの首都テヘランで30日、ファクリザデ氏の葬儀が営まれ、参列したハタミ国防軍需相は「イラン国民の暗殺に対しては必ずやり返す。犯罪を企て、実行したものたちに罰を与える」と述べ、改めて報復を警告しています。""" >>> >>> document = document.replace(" ", "").replace(" ", "").replace("\n", "") >>> sentence_list = document.split("。") >>> pprint(len(sentence_list)) 10 >>> sentence_list = [sentence for sentence in sentence_list if not(sentence == "")] >>> pprint(sentence_list) ['イランで核科学者が何者かに銃撃されて死亡した事件で、地元の国営テレビは関係者の話として、殺害に使用された武器はイスラエル製だと伝えました', 'イランの国防軍需相は「暗殺に対しては必ずやり返す」と改めて報復を警告しています', 'イラン政府によりますと、27日、国防軍需省の研究開発部門トップで、核開発技術を研究していたファクリザデ氏が何者かに銃撃されて死亡しました', 'この事件について、国営テレビの英語チャンネルは、30日、関係者の話として「現場で回収された武器にはイスラエルの軍事産業につながる特徴があり、イスラエル製の武器が使われていた」と伝えました', 'また、国営テレビのアラビア語チャンネルも「衛星を通じて、操作されたイスラエル製の武器が使われた」と伝えています', '一方、保守系のファルス通信は、現場に実行犯の姿はなく、遠隔操作で作動する機関銃が使われた可能性があると伝えています', 'この事件について30日、イスラエルの諜報相は地元のラジオ番組で「誰がやったのかは知らない」とコメントしています', 'イランの首都テヘランで30日、ファクリザデ氏の葬儀が営まれ、参列したハタミ国防軍需相は「イラン国民の暗殺に対しては必ずやり返す', '犯罪を企て、実行したものたちに罰を与える」と述べ、改めて報復を警告しています'] >>> >>> result_list = [return_svo_triple(sentence) for sentence in sentence_list] >>> pprint(result_list) [({'主語': '武器は', '目的語': 'イスラエル製だと', '述語': '伝えました'}, ['事件で、->伝えました', '国営テレビは->伝えました', '話として、->伝えました', '武器は->伝えました', 'イスラエル製だと->伝えました']), ({'主語': '国防軍需相は', '目的語': '報復を', '述語': '警告しています'}, ['国防軍需相は->警告しています', 'やり返す」と->警告しています', '改めて->警告しています', '報復を->警告しています']), ({'述語': '死亡しました'}, ['よりますと、->死亡しました', '27日、->死亡しました', '銃撃されて->死亡しました']), ({'主語': '英語チャンネルは、', '目的語': '使われていた」と', '述語': '伝えました'}, ['事件について、->伝えました', '英語チャンネルは、->伝えました', '30日、->伝えました', '話として->伝えました', '使われていた」と->伝えました']), ({'主語': 'アラビア語チャンネルも', '目的語': '使われた」と', '述語': '伝えています'}, ['また、->伝えています', 'アラビア語チャンネルも->伝えています', '使われた」と->伝えています']), ({'目的語': 'あると', '述語': '伝えています'}, ['一方、->伝えています', 'あると->伝えています']), ({'主語': '諜報相は', '目的語': '知らない」と', '述語': 'コメントしています'}, ['事件について->コメントしています', '30日、->コメントしています', '諜報相は->コメントしています', 'ラジオ番組で->コメントしています', '知らない」と->コメントしています']), ({'主語': '暗殺に対しては', '目的語': '暗殺に対しては', '述語': 'やり返す'}, ['営まれ、->やり返す', 'ハタミ国防軍需相は->やり返す', '暗殺に対しては->やり返す', '必ず->やり返す']), ({'目的語': '報復を', '述語': '警告しています'}, ['述べ、->警告しています', '改めて->警告しています', '報復を->警告しています'])] >>>問題意識

係り受け解析器を用いて、テキストデータから、SVO(SPO)のTriple set([主語, 動詞(述語), 目的語])を返す処理を行う実装コードを探してみたところ、なかなか見当たりませんでした。

そのため、備忘録まで、この記事を立ててみました。

時間をかけて方々を探してみたところ、見つけた以下のコードがうまく動きました。

・ 東邦大学 「2014-01-29 CaboChaによる係り受け解析の利用 ~ 文の主節の骨組を取り出す 」

東邦大学の研究室が公開中のコードを、以下の関数(メソッド)に書き換えてみました。

定義した関数(メソッド)のInput->Outputの入出力仕様・引数と返り値: str -> Tuple[Dict, List] ・引数に渡せるのは、1つの文(sentence)だけです。 ・引数に渡すstr型のデータは、分かち書きにする必要はありません。平文のまま渡します。東邦大学のコードを関数(メソッド)で包んだスクリプト

get_svo_triple.pyimport CaboCha import sys import codecs # https://docs.python.org/ja/3.6/library/typing.html from typing import Dict, Tuple, List def return_svo_triple(sentence:str) -> Tuple[Dict, List]: c = CaboCha.Parser() tree = c.parse(sentence) size = tree.size() myid = 0 ku_list = [] ku = '' ku_id = 0 ku_link = 0 kakari_joshi = 0 kaku_joshi = 0 for i in range(0, size): token = tree.token(i) if token.chunk: if (ku!=''): ku_list.append((ku, ku_id, ku_link, kakari_joshi, kaku_joshi)) #前 の句をリストに追加 kakari_joshi = 0 kaku_joshi = 0 ku = token.normalized_surface ku_id = myid ku_link = token.chunk.link myid=myid+1 else: ku = ku + token.normalized_surface m = (token.feature).split(',') if (m[1] == u'係助詞'): kakari_joshi = 1 if (m[1] == u'格助詞'): kaku_joshi = 1 ku_list.append((ku, ku_id, ku_link, kakari_joshi, kaku_joshi)) # 最後にも前の句をリストに追加 for k in ku_list: if (k[2]==-1): # link==-1? # 述語である jutsugo_id = ku_id # この時のidを覚えておく #述語句 predicate_word = [k[0] for k in ku_list if (k[1]==jutsugo_id)] #for k in ku_list: # if (k[1]==jutsugo_id): # jutsugo_idと同じidを持つ句を探す # print(k[1], k[0], k[2], k[3], k[4]) #述語句に係る句 # jutsugo_idと同じidをリンク先に持つ句を探す word_to_predicate_list = [k[0] for k in ku_list if k[2]==jutsugo_id] # 述語句に係る句 -> 述語句 svo_arrow_text = [str(word_to_predicate) + "->" + str(predicate_word[0]) for word_to_predicate in word_to_predicate_list] #print(svo_arrow_text) svo_dict = {} for num, k in enumerate(ku_list): if (k[2]==jutsugo_id): # jutsugo_idと同じidをリンク先に持つ句を探す if (k[3] == 1): subject_word = k[0] svo_dict["主語"] = subject_word #print(subject_word) if (k[4] == 1): object_word = k[0] svo_dict["目的語"] = object_word #print(object_word) if (k[1] == jutsugo_id): predicate_word = k[0] svo_dict["述語"] = predicate_word #print(predicate_word) return (svo_dict, svo_arrow_text)今後やりたいこと

<1つ目>

・ 以下の論文ほかを参考に、Web空間上のテキストデータから、出来事間の時系列因果構造を抽出したい。

・ さらに、獲得した出来事間の時系列因果構造を、視覚的に把握しやすいように、グラフ構造のネットワーク図に描画したい。・ 石井ほか 「SVO構造を用いた因果関係ネットワーク構築手法について」

<2つ目>

・[主語 -> 述語(動詞など) -> 目的語・補語]の三つ組データ(Triple set)を、Prologなどの論理推論ができるプログラミング言語に与えることで、複数の三つ組データ(Triple set)間の因果関係や概念意味関係を用いた知識推論を行ってみたい。

<3つ目>

・ MaskedTransformerやVideoBERTなどの学習済みモデルを用いて、静止画像や動画の内容説明文(内容要約文、キャプション文)を生成し、その説明文に含まれる[主語 -> 述語(動詞など) -> 目的語・補語]の三つ組データ(Triple set)を抽出したい。

・ 動画の説明文から抜き出した「主語」や「目的語」や「補語」の単語を、DB(データベース)に格納して、固有表現抽出器(Named Entitity Recogniton)を用いて、「人名」や「組織名」や「地名」といった固有表現ラベルを紐付けたい。

・ その結果、特定の人物や組織や地名が登場する静止画や動画を、容易に検索できるプラットフォームを構築したい。MaskedTransformerの「再現実装コード」は、Albert社さんのリポジトリから取得可能です。

・ ( GitHub )ALBERT-Inc/blog_masked_transformer

公開されている学習済み重みファイルはこちらからダウンロードできます。これを解凍し、yc2-2L-e2e-maskというディレクトリの下にある重みファイルを利用して学習してください。

・ Albert社ブログ 「動画認識手法の紹介とキャプション生成手法Masked Transformerについての解説」

・ Show and Tell論文の学習済みモデルの利用方法は以下が参考になる。

: @48saaanさんのQiita記事 「「Show and Tell」の TensorFlow をCPUでお試し」トレーニング済みモデルの準備

GitHubのtensorflow/modelsのIssues「Pretrained model for img2txt? #466」で「here are links to a pre-trained model:」を検索すると、その書き込みの下に3つのリンクがあります。

そこから「im2txt_2016_10_11.2000000.tar.gz」(←finetuned)と「word_counts.txt」を~/test/models/research/im2txtにコピー解凍もしておきます

tar xf im2txt_2016_10_11.2000000.tar.gz rm im2txt_2016_10_11.2000000.tar.gz

- 投稿日:2020-11-30T23:21:27+09:00

【Python】virtualenvで仮想環境を作成する(コマンドプロンプト)

自分用メモ。Windows。

コードの頭に">>"とついているのは、コマンドプロンプトで打ち込むコマンド。前提

Pythonがすでにインストールされてある。

環境を作成したいディレクトリを開く

>> cd C:\Users\UserName\Documents\MyAppまたは、エクスプローラーでディレクトリを開いて、パスに「cmd」と打ち込むと、そのディレクトリでコマンドプロンプトが開ける

virtualenvで仮想環境を作成

virtualenvをまだpipでインストールしていない人は、次のコマンドでインストールする。

>> py -m pip install virtualenv次のコマンドで仮想環境を作成する

>> py -m virtualenv .venv(自分のPCでは)pipやvirtualenvの環境変数は設定されていないので、 それらのコマンドを走らせることはできない。

"py -m" をつけると、pythonがすでにpipでインストールされたライブラリからコマンドをとってきてくれる。

正直この辺の原理はよく知らない。これで、".venv"というフォルダが作成される。中には色々ファイルがある。

今後、pipでインストールするライブラリは、この.venvの中に入っていく。.venv の部分は、"hoge"でも何でもいい。

でも通例として venvか .venv と名付けることが多い(ように思われる)。

.venvとつけておけば、そのフォルダが仮想環境のフォルダとすぐに分かるから、そうしたほうがいい。仮想環境に切り替える

このままだと、仮想環境を作成しただけであって、"いま、この仮想環境を使用していますよ~"ということにはなっていない。

作成した仮想環境を使用中にするには、次のコマンドをうつ。>> .venv\Scripts\Activateこれは、さっき作成された.venv/Scriptsフォルダ内のActivateを実行している。

こうすると、コマンドプロンプトの頭に(.venv)とつくようになる。

仮想環境内でライブラリをインストールする

コマンドプロンプトの頭に(.venv)がついている状態で

>> pip install hogehogeのようにpipでライブラリをインストールすると、仮想環境内にインストールされる。

仮想環境の使用中は、py -m はいらない。仮想環境を終了する

仮想環境の使用を終了するには、次のコマンドをうつ。

>> deactivate

- 投稿日:2020-11-30T23:00:10+09:00

Cisco PSIRT OpenVuln API を使ってみる

はじめに

シスコは サポート 契約のあるパートナーや、ユーザーが利用可能な Support APIを公開しています。

Cisco Support APIs

Cisco Support APIは、受発注に関わるものや、サポートに関わるものなど多く存在しますが、今回は、シスコアカウントがあれば、手軽に使える Cisco PSIRT OpenVuln APIを使ってみます。Cisco PSIRT OpenVuln とは

OpenVuln API は簡単に言うと、Cisco PSIRT(Product Security Incident Response Team) の情報、脆弱性情報を REST API を使って、様々なフォーマットで、効率的に取得できる API です。

これを使うと、REST APIで、特定のIOS version の脆弱性情報や、セキュリティアドバイザリの詳細などを取得することができます。

アカウントセットアップ

まず、Cisco Support API を利用する場合は、 https://apiconsole.cisco.com へアクセスし、APIを有効にする必要があります。

手順

- https://apiconsole.cisco.com へアクセスし Cisco.com アカウントでログイン

- My Apps & Keys タブをクリック

- Register an Application で、アプリケーション名など必要事項を記入(赤枠の部分を埋めます)し、登録

そうすることで、API 利用に必要な KEY と SECRET が発行されます

Python モジュール openVulnQuery を使う

アカウントの設定が完了すれば、 REST API で情報取得ができます。

今回は、コマンドラインツールとしても使える、openVulnQuery が便利なので、これを使ってみます。GitHub - CiscoPSIRT/openVulnQuery: A Python-based client for the Cisco openVuln API

インストール & セットアップ

Pip でインストールをするだけです。

pip install openVulnQuery私の環境では、下記の通り PATH を通ってないよとエラーが出たのでコマンドラインツールとして利用するために、 .bash_profile に PATHを追加

WARNING: The script chardetect is installed in '/Users/USER_ID/Library/Python/3.8/bin' which is not on PATH.

.bash_profile: export PATH="/Users/USER_ID/Library/Python/3.8/bin:$PATH" :openVulnQuery を使うためには、環境変数で、KEY と Secret を渡すか、もしくは、json 形式のファイルに KEY と Secret を記載して、オプションで渡すことで APIにアクセスをします。

- 環境変数で渡す場合

$export CLIENT_ID="xxxxxxx" $export CLIENT_SECRET="yyyyyyy"

- JSON形式のファイルで渡す場合 下記の形式の credential 用のファイルを、一つ作成します。

credential.json{ "CLIENT_ID": "xxxxxxx", "CLIENT_SECRET": "yyyyyyyy" }openVulnQuery の使い方

openVlunQuery に、credential file を --config で指定して、実行すれば、データが取得できます。

$ openVulnQuery -h usage: openVulnQuery [-h] (--all | --advisory <advisory-id> | --cve <CVE-id> | --latest number | --severity [critical, high, medium, low] | --year year | --product product_name | --ios_xe iosxe_version | --ios ios_version | --nxos nxos_version | --aci aci_version) [--csv filepath | --json filepath] [--first_published YYYY-MM-DD:YYYY-MM-DD | --last_published YYYY-MM-DD:YYYY-MM-DD] [-c] [-f [...]] [--user-agent string] [--config filepath]

詳細

Cisco OpenVuln API Command Line Interface optional arguments: -h, --help show this help message and exit --all Retrieves all advisiories --advisory <advisory-id> Retrieve advisories by advisory id --cve <CVE-id> Retrieve advisories by cve id --latest number Retrieves latest (number) advisories --severity [critical, high, medium, low] Retrieve advisories by severity (low, medium, high, critical) --year year Retrieve advisories by year --product product_name Retrieve advisories by product names --ios_xe iosxe_version Retrieve advisories affecting user inputted ios_xe version.Only one version at a time is allowed. --ios ios_version Retrieve advisories affecting user inputted ios version.Only one version at a time is allowed. --nxos nxos_version Retrieve advisories affecting user inputted NX-OS (in standalone mode) version.Only one version at a time is allowed. --aci aci_version Retrieve advisories affecting user inputted NX-OS (in ACI mode) version.Only one version at a time is allowed. --csv filepath Output to CSV with file path --json filepath Output to JSON with file path --first_published YYYY-MM-DD:YYYY-MM-DD Filter advisories based on first_published date YYYY-MM-DD:YYYY-MM-DD USAGE: followed by severity or all --last_published YYYY-MM-DD:YYYY-MM-DD, --last_updated YYYY-MM-DD:YYYY-MM-DD Filter advisories based on last_published date YYYY-MM-DD:YYYY-MM-DD USAGE: followed by severity or all -c, --count Count of any field or fields -f [ ...], --fields [ ...] Separate fields by spaces to return advisory information. Allowed values are: advisory_id, advisory_title, bug_ids, cves, cvrfUrl, cvss_base_score, cwe, first_fixed, first_published, ios_release, ips_signatures, last_updated, product_names, publication_url, sir, summary --user-agent string Announced User-Agent hedar value (towards service) --config filepath Path to JSON file with config (otherwise fallback to environment variables CLIENT_ID and CLIENT_SECRET, or config.py variables, or fail)例1) IOS-XE version 16.2.2 に該当するセキュリティアドバイザリIDとタイトルを一覧表示

openVulnQuery --ios_xe 16.2.2 -f advisory_id advisory_title

出力結果

[ { "advisory_id": "cisco-sa-info-disclosure-V4BmJBNF", "advisory_title": "Cisco IOS and IOS XE Software Information Disclosure Vulnerability" }, { "advisory_id": "cisco-sa-iosxe-isdn-q931-dos-67eUZBTf", "advisory_title": "Cisco IOS and IOS XE Software ISDN Q.931 Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-rommon-secboot-7JgVLVYC", "advisory_title": "Cisco IOS XE ROM Monitor Software Vulnerability" }, { "advisory_id": "cisco-sa-ios-lua-rce-7VeJX4f", "advisory_title": "Cisco IOS XE Software Arbitrary Code Execution Vulnerability" }, { "advisory_id": "cisco-sa-esp20-arp-dos-GvHVggqJ", "advisory_title": "Cisco IOS XE Software for Cisco ASR 1000 Series 20-Gbps Embedded Services Processor IP ARP Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-iosxe-rsp3-rce-jVHg8Z7c", "advisory_title": "Cisco IOS XE Software for Cisco ASR 900 Series Route Switch Processor 3 Arbitrary Code Execution Vulnerabilities" }, { "advisory_id": "cisco-sa-ios-webui-priv-esc-K8zvEWM", "advisory_title": "Cisco IOS XE Software Privilege Escalation Vulnerabilities" }, { "advisory_id": "cisco-sa-ios-xe-webui-multi-vfTkk7yr", "advisory_title": "Cisco IOS XE Software Web Management Framework Vulnerabilities" }, { "advisory_id": "cisco-sa-webui-auth-bypass-6j2BYUc7", "advisory_title": "Cisco IOS XE Software Web UI Authorization Bypass Vulnerability" }, { "advisory_id": "cisco-sa-zbfw-94ckG4G", "advisory_title": "Cisco IOS XE Software Zone-Based Firewall Denial of Service Vulnerabilities" }, { "advisory_id": "cisco-sa-telnetd-EFJrEzPx", "advisory_title": "Telnet Vulnerability Affecting Cisco Products: June 2020" }, { "advisory_id": "cisco-sa-tcl-dos-MAZQUnMF", "advisory_title": "Cisco IOS and IOS XE Software Tcl Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-ikev2-9p23Jj2a", "advisory_title": "Cisco IOS and IOS XE Software Internet Key Exchange Version 2 Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-ssh-dos-Un22sd2A", "advisory_title": "Cisco IOS and IOS XE Software Secure Shell Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-sip-Cv28sQw2", "advisory_title": "Cisco IOS and IOS XE Software Session Initiation Protocol Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-tcl-ace-C9KuVKmm", "advisory_title": "Cisco IOS and IOS XE Software Tcl Arbitrary Code Execution Vulnerability" }, { "advisory_id": "cisco-sa-iosxe-ewlc-dos-TkuPVmZN", "advisory_title": "Cisco IOS XE Software Catalyst 9800 Series Wireless Controllers Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-iosxe-digsig-bypass-FYQ3bmVq", "advisory_title": "Cisco IOS XE Software Digital Signature Verification Bypass Vulnerability" }, { "advisory_id": "cisco-sa-priv-esc1-OKMKFRhV", "advisory_title": "Cisco IOS XE Software Privilege Escalation Vulnerability" }, { "advisory_id": "cisco-sa-priv-esc3-GMgnGCHx", "advisory_title": "Cisco IOS XE Software Privilege Escalation Vulnerability" }, { "advisory_id": "cisco-sa-web-cmdinj2-fOnjk2LD", "advisory_title": "Cisco IOS XE Software Web UI Command Injection Vulnerability" }, { "advisory_id": "cisco-sa-webui-PZgQxjfG", "advisory_title": "Cisco IOS XE Software Web UI Privilege Escalation Vulnerability" }, { "advisory_id": "cisco-sa-sxp-68TEVzR", "advisory_title": "Cisco IOS, IOS XE, and NX-OS Software Security Group Tag Exchange Protocol Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-ios-nxos-onepk-rce-6Hhyt4dC", "advisory_title": "Cisco IOS, IOS XE, IOS XR, and NX-OS Software One Platform Kit Remote Code Execution Vulnerability" }, { "advisory_id": "cisco-sa-20190828-iosxe-rest-auth-bypass", "advisory_title": "Cisco REST API Container for IOS XE Software Authentication Bypass Vulnerability" }, { "advisory_id": "cisco-sa-20190925-sip-dos", "advisory_title": "Cisco IOS and IOS XE Software Session Initiation Protocol Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20190925-tsec", "advisory_title": "Cisco IOS and IOS XE Software Change of Authorization Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20190925-http-client", "advisory_title": "Cisco IOS and IOS XE Software HTTP Client Information Disclosure Vulnerability" }, { "advisory_id": "cisco-sa-20190925-identd-dos", "advisory_title": "Cisco IOS and IOS XE Software IP Ident Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20190925-sbxss", "advisory_title": "Cisco IOS and IOS XE Software Stored Banner Cross-Site Scripting Vulnerability" }, { "advisory_id": "cisco-sa-20190925-iosxe-codeexec", "advisory_title": "Cisco IOS XE Software Arbitrary Code Execution Vulnerability" }, { "advisory_id": "cisco-sa-20190925-awr", "advisory_title": "Cisco IOS XE Software ASIC Register Write Vulnerability" }, { "advisory_id": "cisco-sa-20190925-iosxe-fsdos", "advisory_title": "Cisco IOS XE Software Filesystem Exhaustion Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20190925-sip-alg", "advisory_title": "Cisco IOS XE Software NAT Session Initiation Protocol Application Layer Gateway Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20190925-utd", "advisory_title": "Cisco IOS XE Software Unified Threat Defense Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20190925-vman", "advisory_title": "Cisco NX-OS and IOS XE Software Virtual Service Image Signature Bypass Vulnerability" }, { "advisory_id": "cisco-sa-20160525-ipv6", "advisory_title": "Cisco Products IPv6 Neighbor Discovery Crafted Packet Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20190612-iosxe-csrf", "advisory_title": "Cisco IOS XE Software Web UI Cross-Site Request Forgery Vulnerability" }, { "advisory_id": "cisco-sa-20190513-webui", "advisory_title": "Cisco IOS XE Software Web UI Command Injection Vulnerability" }, { "advisory_id": "cisco-sa-20170629-snmp", "advisory_title": "SNMP Remote Code Execution Vulnerabilities in Cisco IOS and IOS XE Software" }, { "advisory_id": "cisco-sa-20190327-ios-infoleak", "advisory_title": "Cisco IOS and IOS XE Software Hot Standby Router Protocol Information Leak Vulnerability" }, { "advisory_id": "cisco-sa-20190327-ipsla-dos", "advisory_title": "Cisco IOS and IOS XE Software IP Service Level Agreement Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20190327-isdn", "advisory_title": "Cisco IOS and IOS XE Software ISDN Interface Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20190327-pnp-cert", "advisory_title": "Cisco IOS and IOS XE Software Network Plug-and-Play Agent Certificate Validation Vulnerability" }, { "advisory_id": "cisco-sa-20190327-nbar", "advisory_title": "Cisco IOS and IOS XE Software Network-Based Application Recognition Denial of Service Vulnerabilities" }, { "advisory_id": "cisco-sa-20190327-call-home-cert", "advisory_title": "Cisco IOS and IOS XE Software Smart Call Home Certificate Validation Vulnerability" }, { "advisory_id": "cisco-sa-20190327-afu", "advisory_title": "Cisco IOS XE Software Arbitrary File Upload Vulnerability" }, { "advisory_id": "cisco-sa-20190327-xecmd", "advisory_title": "Cisco IOS XE Software Command Injection Vulnerability" }, { "advisory_id": "cisco-sa-20190327-iosxe-cmdinj", "advisory_title": "Cisco IOS XE Software Command Injection Vulnerability" }, { "advisory_id": "cisco-sa-20190327-mgmtacl", "advisory_title": "Cisco IOS XE Software Gigabit Ethernet Management Interface Access Control List Bypass Vulnerability" }, { "advisory_id": "cisco-sa-20190109-tcp", "advisory_title": "Cisco IOS and IOS XE Software TCP Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20180926-ipsec", "advisory_title": "Cisco IOS XE Software and Cisco ASA 5500-X Series Adaptive Security Appliance IPsec Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20180926-cdp-dos", "advisory_title": "Cisco IOS and IOS XE Software Cisco Discovery Protocol Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20180926-ipv6hbh", "advisory_title": "Cisco IOS and IOS XE Software IPv6 Hop-by-Hop Options Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20180926-ospfv3-dos", "advisory_title": "Cisco IOS and IOS XE Software OSPFv3 Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20180926-pnp-memleak", "advisory_title": "Cisco IOS and IOS XE Software Plug and Play Agent Memory Leak Vulnerability" }, { "advisory_id": "cisco-sa-20180926-sm1t3e3", "advisory_title": "Cisco IOS and IOS XE Software SM-1T3/E3 Service Module Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20180926-vtp", "advisory_title": "Cisco IOS and IOS XE Software VLAN Trunking Protocol Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20180926-iosxe-cmdinj", "advisory_title": "Cisco IOS XE Software Command Injection Vulnerabilities" }, { "advisory_id": "cisco-sa-20180926-digsig", "advisory_title": "Cisco IOS XE Software Digital Signature Verification Bypass Vulnerability" }, { "advisory_id": "cisco-sa-20180926-webdos", "advisory_title": "Cisco IOS XE Software HTTP Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20180926-macsec", "advisory_title": "Cisco IOS XE Software MACsec MKA Using EAP-TLS Authentication Bypass Vulnerability" }, { "advisory_id": "cisco-sa-20180926-sip-alg", "advisory_title": "Cisco IOS XE Software NAT Session Initiation Protocol Application Layer Gateway Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20180926-shell-access", "advisory_title": "Cisco IOS XE Software Shell Access Authentication Bypass Vulnerability" }, { "advisory_id": "cisco-sa-20180926-webuidos", "advisory_title": "Cisco IOS XE Software Web UI Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20180328-smi", "advisory_title": "Cisco IOS and IOS XE Software Smart Install Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20180328-smi2", "advisory_title": "Cisco IOS and IOS XE Software Smart Install Remote Code Execution Vulnerability" }, { "advisory_id": "cisco-sa-20180328-lldp", "advisory_title": "Cisco IOS, IOS XE, and IOS XR Software Link Layer Discovery Protocol Buffer Overflow Vulnerabilities" }, { "advisory_id": "cisco-sa-20180328-qos", "advisory_title": "Cisco IOS and IOS XE Software Quality of Service Remote Code Execution Vulnerability" }, { "advisory_id": "cisco-sa-20180328-dhcpr1", "advisory_title": "Cisco IOS and IOS XE Software DHCP Version 4 Relay Heap Overflow Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20180328-dhcpr2", "advisory_title": "Cisco IOS and IOS XE Software DHCP Version 4 Relay Reply Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20180328-ike", "advisory_title": "Cisco IOS and IOS XE Software Internet Key Exchange Memory Leak Vulnerability" }, { "advisory_id": "cisco-sa-20180328-ipv4", "advisory_title": "Cisco IOS XE Software for Cisco Catalyst Switches IPv4 Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20180328-igmp", "advisory_title": "Cisco IOS XE Software Internet Group Management Protocol Memory Leak Vulnerability" }, { "advisory_id": "cisco-sa-20180328-snmp-dos", "advisory_title": "Cisco IOS XE Software Simple Network Management Protocol Double-Free Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20180328-privesc1", "advisory_title": "Cisco IOS XE Software User EXEC Mode Root Shell Access Vulnerabilities" }, { "advisory_id": "cisco-sa-20180328-xepriv", "advisory_title": "Cisco IOS XE Software Web UI Remote Access Privilege Escalation Vulnerability" }, { "advisory_id": "cisco-sa-20170419-energywise", "advisory_title": "Cisco IOS and IOS XE Software EnergyWise Denial of Service Vulnerabilities" }, { "advisory_id": "cisco-sa-20170726-anicrl", "advisory_title": "Cisco IOS XE Software Autonomic Networking Infrastructure Certificate Revocation Vulnerability" }, { "advisory_id": "cisco-sa-20171103-bgp", "advisory_title": "Cisco IOS XE Software Ethernet Virtual Private Network Border Gateway Protocol Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20170927-ike", "advisory_title": "Cisco IOS and IOS XE Software Internet Key Exchange Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20170927-pnp", "advisory_title": "Cisco IOS and IOS XE Software Plug-and-Play PKI API Certificate Validation Vulnerability" }, { "advisory_id": "cisco-sa-20170727-ospf", "advisory_title": "Multiple Cisco Products OSPF LSA Manipulation Vulnerability" }, { "advisory_id": "cisco-sa-20170726-aniacp", "advisory_title": "Cisco IOS and IOS XE Software Autonomic Control Plane Channel Information Disclosure Vulnerability" }, { "advisory_id": "cisco-sa-20170726-anidos", "advisory_title": "Cisco IOS and IOS XE Software Autonomic Networking Infrastructure Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20170320-ani", "advisory_title": "Cisco IOS and IOS XE Software Autonomic Networking Infrastructure Registrar Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20170320-aniipv6", "advisory_title": "Cisco IOS and IOS XE Software IPv6 Denial of Service Vulnerability" }, { "advisory_id": "cisco-sa-20161115-iosxe", "advisory_title": "Cisco IOS XE Software Directory Traversal Vulnerability" }, { "advisory_id": "cisco-sa-20160916-ikev1", "advisory_title": "IKEv1 Information Disclosure Vulnerability in Multiple Cisco Products" } ]例2) CVE ID "CVE-2010-3043" で セキュリティアドバイザリの内容を確認

openVulnQuery --cve CVE-2010-3043

出力結果

[ { "advisory_id": "cisco-sa-20110201-webex", "advisory_title": "Multiple Cisco WebEx Player Vulnerabilities", "bug_ids": [ "NA" ], "cves": [ "CVE-2010-3041", "CVE-2010-3042", "CVE-2010-3043", "CVE-2010-3044", "CVE-2010-3269" ], "cvrfUrl": "https://tools.cisco.com/security/center/contentxml/CiscoSecurityAdvisory/cisco-sa-20110201-webex/cvrf/cisco-sa-20110201-webex_cvrf.xml", "cvss_base_score": "9.3", "cwe": [ "CWE-94" ], "first_published": "2011-02-01T16:00:00", "ips_signatures": [ { "legacy_ips_id": "cisco-sa-20110201-webex", "legacy_ips_url": "https://tools.cisco.com/security/center/viewIpsSignature.x?signatureId=36910&signatureSubId=0&softwareVersion=6.0&releaseVersion=S682", "release_version": "S682", "software_version": "6.0" } ], "last_updated": "2011-02-01T16:00:00", "product_names": [ "NA" ], "publication_url": "http://tools.cisco.com/security/center/content/CiscoSecurityAdvisory/cisco-sa-20110201-webex", "sir": "Critical", "summary": "<p>Multiple buffer overflow vulnerabilities exist in the Cisco WebEx\n\t Recording Format (WRF) and Advanced Recording Format (ARF) Players. In some\n\t cases, exploitation of the vulnerabilities could allow a remote attacker to\n\t execute arbitrary code on the system of a targeted user.</p> \n <p> </p> \n <p> The Cisco WebEx Players are applications that are used to\n\t play back WebEx meeting recordings that have been recorded on the computer of\n\t an on-line meeting attendee. The players can be automatically installed when\n\t the user accesses a recording file that is hosted on a WebEx server. The player\n\t can also be manually installed for offline playback after downloading the\n\t application from <a target=\"_blank\" href=\"http://www.webex.com\">www.webex.com</a>\n<img alt=\"leavingcisco.com\" height=\"18\" width=\"18\" src=\"http://www.cisco.com/images/exit.gif\" />.</p> \n <p> </p> \n <p> If the WebEx recording player was automatically installed,\n\t it will be automatically upgraded to the latest, non-vulnerable version when\n\t users access a recording file that is hosted on a WebEx server. If the WebEx\n\t recording player was manually installed, users will need to manually install a\n\t new version of the player after downloading the latest version from\n\t <a target=\"_blank\" href=\"http://www.webex.com\">www.webex.com</a>\n<img alt=\"leavingcisco.com\" height=\"18\" width=\"18\" src=\"http://www.cisco.com/images/exit.gif\" />.</p> \n <p> </p> \n <p> Cisco has released software updates that address these vulnerabilities.</p> \n <p>This advisory is posted at\n\t <a style=\"WORD-BREAK:BREAK-ALL;\" href=\"http://tools.cisco.com/security/center/content/CiscoSecurityAdvisory/cisco-sa-20110201-webex\">http://tools.cisco.com/security/center/content/CiscoSecurityAdvisory/cisco-sa-20110201-webex</a>.\n\t </p> \n \n\n" } ]例3) 2020年にリリースされた Security Impact Rating (sir) が Critical な PSIRT の数を調べる

openVulnQuery --year 2020 -f sir | grep -c "Critical"

出力結果

25まとめ

このような形で 必要な PSIRT の情報を入手することができます。

運用中の多くのネットワーク機器の脆弱性情報を API を使うことで、まとめて取得できるため、活用いただけるシーンは多いのではないかと思います。今回は、コマンドラインでの例を中心に記載しましたが、Python ライブラリとしてプログラムの中に組み込むことで、より効率的な情報収集や、その他アプリケーションとの連携が可能です

- 投稿日:2020-11-30T22:36:27+09:00

pydubを使うためにdockerにffmpegをインストール

djangoでwebアプリを作っている時に、m4a形式の音声をwav形式に変換するために、docker環境にpydubを入れようとしたのですが、pydubを使うためにはffmpegというossをインストールする必要があるとのことでした(pydubはffmpegのラッパーとのこと)。

ところがffmpegの公式ページに行くとコマンドでのインストール方法が見つからなく、必要なコマンドをDockerfileに書けないなといった状況でした。幸い、githubで参考になる書き方を見つけたので、時間を溶かさずにすみましたが、忘れないように備忘録としてメモします。DockerfileFROM python:3.8 ENV PYTHONBUFFERD 1 RUN mkdir /workspace WORKDIR /workspace COPY requirements.txt /workspace/ RUN apt-get update && \ apt-get -y install ffmpeg libavcodec-extra && \ pip install --upgrade pip && \ pip install -r requirements.txt CMD ["python3","manage.py","runserver","0.0.0.0:8000"] EXPOSE 8000このようなDockerfileをbuildすることで、Docker環境で無事ffmpegをインストールし、pydubを使うことができました(requirement.txt内にpydubを書く)。

なお、参考にしたgithubのurlは下記です。

https://github.com/546669204/docker-pydub/blob/master/Dockerfile

- 投稿日:2020-11-30T22:28:13+09:00

雰囲気で使うMedic

一年ぶりまして。

今年もAdventCalendarの季節がやってまいりました!

今年のMaya Advent Calendarはというと例年と同様に大好評(?)のようで、安心しました(涙目)さて、それでは今回はMedicという個人的に触ってるツールについてお話します。

Medicについて

Medicとは、Mayaで動作するオープンソースのデータチェックツールです。

Python、C++でテスト項目(Tester)を拡張でき、それらを一つのチェックリスト(Karte)として統合することでシーン全体または選択したノードに対して一括でデータチェックを走らせることができます。

(画像左:Karte画面、画像右:Tester画面)

この記事では細かいことは置いておいて、TesterとKarteというMedicの中でも重要な2つの要素について触れていきます。

Tester(テスター)

Testerはチェック項目本体です。

Testerは先述した通りPythonとC++で拡張できますが、私はC++ワカラナイのでここではPythonのTesterについて書きます。Testerの書き方は基本的にここに書いてある情報しかありません。

(ググってみても第三者によるそれらしい情報のようなものは殆ど見つけられませんでした。)これだけの情報だと少し心細さはありますが、Medicには最初からお手本となるような便利なTesterがそれなりのボリュームで用意されているため、それらのコードを読むことで大体の雰囲気を掴むことが出来ました。

実際のコードを見ていきましょう。

example1: anyLayer.py (code link)

これはシーン内にBaseAnimation, defaultRenderLayer, defaultLayerがある場合に検知するTesterです。

上画像の例ではlayer1が存在するためエラー表示になっています。このTesterのコードを例に、それぞれのブロックで何が行われているか解説していきます。

AnyLayer(medic.PyTester)

class AnyLayer(medic.PyTester): def __init__(self): super(AnyLayer, self).__init__() ...Testerは必ず

medic.PyTesterを継承する必要があります。

このPyTesterの内容をオーバーライドすることで独自のTesterが出来上がるわけです。Name

def Name(self): return "AnyLayer"GUIのTester一覧画面に表示される文字列を設定する関数です。

Description

def Description(self): return "Check if any render, anim or display layer exists"GUIに表示されるTesterの説明文を設定する関数です。

Match

def Match(self, node): return node.object().hasFn(OpenMaya.MFn.kDisplayLayer) or node.object().hasFn(OpenMaya.MFn.kAnimLayer) or node.object().hasFn(OpenMaya.MFn.kRenderLayer)ここではTesterの対象となるノードの条件を記載します。

このコードの例ではkDisplayLayer,kAnimLayer,kRenderLayerがフィルタリングされます。引数の

nodeはMedic独自のMdNodeというノードが入っていて、node.object()と書くことでMObjectを呼び出しhasFunでノードのtypeを判定しています。Medicではこの

nodeが非常に重要になってきます。

nodeの中身は詳しく知りたい方はこちらのコードをご覧ください。test

def test(self, node): if node.name() not in ["BaseAnimation", "defaultRenderLayer", "defaultLayer"]: return medic.PyReport(node) return NoneMatchでフィルタリングされたnodeはこのtestでデータチェックが行われます。

このコードの例ではnode.name()でノード名の文字列を取得し、その文字列が"BaseAnimation", "defaultRenderLayer", "defaultLayer"以外であればmedic.PyReport(node)を返します。

この「medic.PyReport(node)を返す」という部分がエラーを検出したということになり、検出されたノードはGUIのListViewに一覧されます。

エラーが検出されなかった場合はNoneを返します。fix

def IsFixable(self): return True def fix(self, report, params): node = report.node() if node.dg().isFromReferencedFile(): return False if node.dg().isLocked(): node.dg().setLocked(False) cmds.delete(node.name()) return TrueMedicではtestで検出したエラーを修正(fix)するロジックを書くこともできます。

この処理はtestと違って実際のデータを弄ることになるため、もしfixを作成する場合は気を付けて書く必要があります。コードの例ではまず

report.node()でtestに引っかかったnodeを取得し→

そのnodeがリファレンスだった場合は処理を中断しFalseを返す、リファレンスでない場合は→

そのノード(レイヤー)がロックされているかどうかを調べ、Trueならロックを解除、Falseならそのまま→

cmds.delete(node.name())でノードを削除し→

fix処理が完了といった処理内容になっています。

IsFixbleはこのTesterがエラーを修正できる能力を持っているかどうかを表すためのもの(GUIのfixボタンをenableにするためのもの)なので、もしfixを書くならセットでIsFixbleをオーバーライドしてTrueを返しましょう。Create

def Create(): return AnyLayer()いまいち詳しいことは分かっていませんが、とりあえずCreateでこのTester本体のclassのインスタンスを返す必要があるようです。

深く考えず、おまじないだと思って忘れずに書きましょう。testの補足:GUIのListViewからコンポーネントを選択できるようにする

「transformノードの名前がルールと違うかどうか」を調べるようなTesterだった場合は問題のノードはどれか分かるだけで問題ないと思います。

しかし、「とあるメッシュの全頂点のウェイト値がルール通りかどうか(小数点第3位以下が切り捨てられてるか 等)」を調べるようなTesterの場合、問題のあるメッシュと合わせて問題のある頂点も選択できた方が便利だと思います。実はMedicではそういった操作もサポートしています。

しかし、標準のTester、具体的にはpythonで書かれたTesterにはそういった処理がどれにも書かれていません。それではどこに書かれているのかというと、C++で書かれたTesterの中に答えが書かれています。

少しだけコードを覗いてみましょう。

example2: nonManifoldVertex.cpp (github link)

このTesterのコードの37~66行目に書かれている内容がその答えになります。

一応コードを解説すると、MItMeshVertex itvtx(node->getPath());nodeの持つdagPathから

MItMeshVertexイテレーターのitvtxを作成し、MFnSingleIndexedComponent comp; MObject comp_obj = comp.create(MFn::kMeshVertComponent);

MFnSingleIndexedComponent型のcompと、

comp.create(MFn::kMeshVertComponent)で生成したMObjectをもったオブジェクトcomp_objを生成し、while (!itvtx.isDone()) { MIntArray faces; MIntArray edges; itvtx.getConnectedFaces(faces); itvtx.getConnectedEdges(edges); if ((edges.length() - faces.length()) > 1) { result = true; comp.addElement(itvtx.index()); } itvtx.next(); }全頂点をイテレーションして問題のある頂点がある場合はresultにtrueを代入すると同時に頂点のindexをcompに格納しています。

そして、resultがfalseであれば

return 0を返し、tureであればMdReport(Python TesterのPyReportに相当)を返します。return new MdReport(node, comp_obj);ここでMdReportの第2引数に注目すると、

comp_objが渡されているのが分かると思います。

察しの良い人はお気づきかと思いますが、PyReportでも同様に第2引数に問題のあるコンポーネントのインデックスが格納されたMObjectを渡してあげるとGUIから問題のあるコンポーネントを選択できるようになります。少し難点なのは、コンポーネントのインデックスが格納されたMObjectを生成する必要がある都合上、

OpenMayaをある程度理解して使える必要があることかなと思います。

今までcmdsやpymelで慣れてきた人にとっては少しハードルがあるかもしれませんが、頑張りましょう。Testerまとめ

Testerとは要は

Matchでテストしたいノードをフィルタリングし、testで実際にテストして問題を検出し、必要に応じてfixで修正するという役割を持ったモジュールです。Medicにおいてもっとも重要な要素なので、Medicを使うなら是非マスターしたいですね。

Karte(カルテ)

Karteは先ほど説明したTesterをひとまとめにするためのものです。

例えばモデリング工程であればモデリング工程用のTesterをひとまとめにし、セットアップ工程ではセットアップ工程用のTesterをひとまとめにするなど、そういった用途で使います。Karteの作り方はTesterと比べると非常にシンプルです。

example3: all.karte (github link)

これがall.karteの全文です。

名前から分かる通り全てのTesterを表示します。{ "Name": "All", "Description": "All testers", "Testers": ["*"], }jsonのような構文になっていて、これをもとに目的に合わせて内容を書き換えることでKarteを作成します。

例えば以下のようなKarteの場合、{ "Name": "Modeling", "Description": "Modeling testers", "Testers": [ "NonManifoldEdge", "NonManifoldVertex", "NonUniqueName", "ZeroLengthEdge" ] }Karteまとめ

全ての工程、全てのプロジェクトですべてのTesterが必要になるかというとそういうわけではないと思います。

そういった場合のこのKarteを使用して、必要なTesterだけをまとめたチェックリストを作りましょう。まとめ

データチェックツールの類は各社で独自に用意されていることが多いと思います。

ただ、0から作るとなるとツールそのものを用意したりUIを用意したりそれらを更新するシステムを作ったりとそれなりにコストがかかると思います。そこで、Medicはこれからチェックツールを用意しようとしている場合に検討する候補の一つとしておすすめです。

データチェックという非クリエイティブな作業をとことん自動化して、クリエイティブな作業に費やす時間を増やしたいですね!

明日の記事はUnPySideさんの記事です。お楽しみに!

- 投稿日:2020-11-30T22:19:08+09:00

【調査中】Tkinter + CV2 + pyzbarでプログラムがクラッシュする

いきさつ

以前親戚の八百屋(?)に納品した出退勤システムをQRコード対応仕様にアップデートしようとコードを組んでいた所、何やらPythonがクラッシュする自体に陥った

この問題は?

進行中

利用中のPCについて

Macbook Pro 2019年モデル・CPU Intel Core i7・メモリ 16GB・ストレージ1TB(内200GBはBootCampでWindows領域に割り当て)

Dynabook T7(2019年夏モデル)・CPU Intel Core i7 8565U・メモリ 8GB・ストレージ 256GB+1TB デュアルストレージ(家電量販店オリジナルカスタムモデルのため機種のメーカー公式スペックと若干の相違あり)やりたかったこと

QRコードを読み込み、もし「従業員」なら登録完了音声を鳴らし、もし「来訪者」として登録されていたら、登録完了音声とともにその来訪者とアポを取っている担当の人間の端末に通知する

その際、画面上にTkinterのmessageboxを利用し、「OO様、お待ちしておりました。只今担当の人間を呼び出しております」というような表示をするシステムを作りたかった状況

QRコードを利用するシステムは作ったことがなかったので、まずは先駆者の方のコードを写経し、それをカスタムして雰囲気を掴み、本格的にアップデート用のプログラムを書いていく作戦にした。

そこで今回は、一番分かりやすかったこちらの方のコードを参考に、以下のようなコードに改造してみた。qrtest.pyfrom pyzbar.pyzbar import decode import cv2 from pygame import mixer from tkinter import messagebox as mbox systemonly = "" cap = cv2.VideoCapture(0) font = cv2.FONT_HERSHEY_SIMPLEX while cap.isOpened(): ret,frame = cap.read() if ret == True: d = decode(frame) if d: for barcode in d: x,y,w,h = barcode.rect cv2.rectangle(frame,(x,y),(x+w,y+h),(0,255,0),2) barcodeData = barcode.data.decode('utf-8') if(systemonly != barcodeData): mixer.init() qrlist = barcodeData.split(",") if(qrlist[1] != "Visitor"): mixer.music.load("sound/recognized.mp3") mixer.music.play(1) systemonly = barcodeData elif(qrlist[1] == "Visitor"): mixer.music.load("sound/visitor.mp3") mixer.music.play(1) mbox.showinfo("Welcome",f"お待ちしておりました。{qrlist[0]}様。\n担当の者が向かいます。しばらくお待ち下さい。") systemonly = barcodeData cv2.imshow('QRTEST',frame) if cv2.waitKey(1) & 0xFF == ord('q'): break cap.release()そして「来訪者QR」を読み込ませて発生したエラーが以下のようなもの。

2020-11-30 21:33:22.249 python[2161:55317] -[NSApplication macMinorVersion]: unrecognized selector sent to instance 0x7fb09c47c3a0 2020-11-30 21:33:22.251 python[2161:55317] *** Terminating app due to uncaught exception 'NSInvalidArgumentException', reason: '-[NSApplication macMinorVersion]: unrecognized selector sent to instance 0x7fb09c47c3a0' *** First throw call stack: ( 0 CoreFoundation 0x00007fff204b76af __exceptionPreprocess + 242 1 libobjc.A.dylib 0x00007fff201ef3c9 objc_exception_throw + 48 2 CoreFoundation 0x00007fff20539c85 -[NSObject(NSObject) __retain_OA] + 0 3 CoreFoundation 0x00007fff2041f06d ___forwarding___ + 1467 4 CoreFoundation 0x00007fff2041ea28 _CF_forwarding_prep_0 + 120 5 libtk8.6.dylib 0x000000011ffe7db9 SetCGColorComponents + 265 6 libtk8.6.dylib 0x000000011ffe867a TkpGetColor + 250 7 libtk8.6.dylib 0x000000011ff22aa9 Tk_GetColor + 153 8 libtk8.6.dylib 0x000000011ff128e6 Tk_Get3DBorder + 134 9 libtk8.6.dylib 0x000000011ff1274f Tk_Alloc3DBorderFromObj + 127 10 libtk8.6.dylib 0x000000011ff23fad DoObjConfig + 941 11 libtk8.6.dylib 0x000000011ff23ae5 Tk_InitOptions + 357 12 libtk8.6.dylib 0x000000011ff239c5 Tk_InitOptions + 69 13 libtk8.6.dylib 0x000000011ff54b5c CreateFrame + 1548 14 libtk8.6.dylib 0x000000011ff54e37 TkListCreateFrame + 151 15 libtk8.6.dylib 0x000000011ff4c7f8 Initialize + 2168 16 _tkinter.cpython-38-darwin.so 0x0000000115e7768b Tcl_AppInit + 91 17 _tkinter.cpython-38-darwin.so 0x0000000115e7734e Tkapp_New + 590 18 _tkinter.cpython-38-darwin.so 0x0000000115e770ee _tkinter_create_impl + 222 19 _tkinter.cpython-38-darwin.so 0x0000000115e76bd6 _tkinter_create + 182 20 python 0x0000000109e17644 cfunction_vectorcall_FASTCALL + 84 21 python 0x0000000109ef0f20 _PyEval_EvalFrameDefault + 45072 22 python 0x0000000109ee412d _PyEval_EvalCodeWithName + 557 23 python 0x0000000109dbb19a _PyFunction_Vectorcall + 426 24 python 0x0000000109db97dd _PyObject_FastCallDict + 93 25 python 0x0000000109e3ff52 slot_tp_init + 178 26 python 0x0000000109e4f4c1 type_call + 289 27 python 0x0000000109db9ad7 _PyObject_MakeTpCall + 167 28 python 0x0000000109ef13d1 _PyEval_EvalFrameDefault + 46273 29 python 0x0000000109dbb0e8 _PyFunction_Vectorcall + 248 30 python 0x0000000109ef0f20 _PyEval_EvalFrameDefault + 45072 31 python 0x0000000109ee412d _PyEval_EvalCodeWithName + 557 32 python 0x0000000109dbb19a _PyFunction_Vectorcall + 426 33 python 0x0000000109ef0f20 _PyEval_EvalFrameDefault + 45072 34 python 0x0000000109ee412d _PyEval_EvalCodeWithName + 557 35 python 0x0000000109dbb19a _PyFunction_Vectorcall + 426 36 python 0x0000000109db97dd _PyObject_FastCallDict + 93 37 python 0x0000000109e3ff52 slot_tp_init + 178 38 python 0x0000000109e4f4c1 type_call + 289 39 python 0x0000000109db9ad7 _PyObject_MakeTpCall + 167 40 python 0x0000000109ef13d1 _PyEval_EvalFrameDefault + 46273 41 python 0x0000000109ee412d _PyEval_EvalCodeWithName + 557 42 python 0x0000000109dbb19a _PyFunction_Vectorcall + 426 43 python 0x0000000109ef0e2b _PyEval_EvalFrameDefault + 44827 44 python 0x0000000109ee412d _PyEval_EvalCodeWithName + 557 45 python 0x0000000109dbb19a _PyFunction_Vectorcall + 426 46 python 0x0000000109dba4a9 PyVectorcall_Call + 121 47 python 0x0000000109ef1829 _PyEval_EvalFrameDefault + 47385 48 python 0x0000000109ee412d _PyEval_EvalCodeWithName + 557 49 python 0x0000000109dbb19a _PyFunction_Vectorcall + 426 50 python 0x0000000109ef0f20 _PyEval_EvalFrameDefault + 45072 51 python 0x0000000109ee412d _PyEval_EvalCodeWithName + 557 52 python 0x0000000109f5c346 PyRun_FileExFlags + 358 53 python 0x0000000109f5ba91 PyRun_SimpleFileExFlags + 529 54 python 0x0000000109f842df pymain_run_file + 383 55 python 0x0000000109f839ab pymain_run_python + 523 56 python 0x0000000109f83745 Py_RunMain + 37 57 python 0x0000000109f84e11 pymain_main + 49 58 python 0x0000000109d8d768 main + 56 59 libdyld.dylib 0x00007fff20360631 start + 1 60 ??? 0x0000000000000002 0x0 + 2 ) libc++abi.dylib: terminating with uncaught exception of type NSException zsh: abort python ReleaseObserver.pyおまけにMacからもGUIで警告が表示されている。こんな感じの↓

こんな親切に出してくれているのに、同じエラーが出ている人間が殆ど居ない上に原因がわからないしmessageboxを表示させなければエラーが出ないものだから、段々と腹が立ってきた。

実は似たようなエラーはゴロゴロと転がってはいるものの、どれも私のMacで発生したエラーとは異なる。

私のエラーの2行目、この部分↓'-[NSApplication macMinorVersion]:大抵同じようなエラーが発生している人は、同じ部分がこの様になっている↓

'-[NSApplication _setup:]:macMinorVersionというエラーは相当珍しいということを発生件数が物語っている。

いろいろ試した。MatplotlibとTkinterが喧嘩してるのではとか(そもそも使ってないけど、内部的に似たようなもの使っているのかも?という淡い期待を込めて)、tkaggがどうとか、とにかく目に入るものすべてを試したが動作せず。

当たり前。エラーがそもそも違うのだから、対処法も違うに決まっている。仮説

上のエラーにはmacMinorVersionという文言が表示されている。

私はちょっぴりこれに対して心当たりがある。

というのも、11月12日(日本時間では確か13日)、リリース日当日にMacOSをBigSurにアップデートしているのだ。

別に仕事じゃないし、どうせ不具合なんか起きてもCatalinaに戻せばいいや〜、なんて軽く考えていた。

もしかしたらこれが原因かもしれない。実験

幸いにも、私はWindowsマシンの「Dynabook」を所有している。

今回はこのDynabookを用いて検証していこう・・・と思ったが、WindowsではPyzbarがバグって動作しない。現在こちらの問題も調査中。何がしたかったか

とりあえずまずこんなエラーが出ているということを共有したかった。

解決策をご存じの方は是非教えて下さい。

引き続きこの問題を調査していきます。

何か分かったら追記します。 P

- 投稿日:2020-11-30T21:29:44+09:00

Ramp制御を含むGUIを作る

この記事はMaya Advent Calender 2020の3日目の記事です。

AdventCalenderに初めて参加させていただきます。はじめに

Rampのカーブを入力として利用したツールを制作する為に調べました。

今回は、PySideではなくmayaコマンドでGUIを作っています。サンプル

下記のコードを実行すると、GUIが表示されます。

import maya.cmds as cmds import maya.mel as mel class rampWindow(object): @classmethod def showUI(cls): """ showUI UIを表示させます。 """ win = cls() win.create() return win def deleteUI(self, *args): """ deleteUI UIを削除します。 rampアトリビュート用のNullを削除します。 """ cmds.deleteUI(self.window, window=True) self.deleteRampNode() def deleteRampNode(self, *args): """ deleteRampNode rampアトリビュート用のNullを削除します。 ウィンドウの×を押した時のコマンド用。 """ if cmds.ls(self.nodeName): cmds.delete( self.nodeName ) def __init__(self): """ __init__ 初期化。 """ self.window = 'rampWindow' self.title = 'rampWindow' self.width=200 self.rampName = "ramp" self.nodeName = "rampNull" def create(self): """ create レイアウト作成。 """ # 多重ウィンドウ対応 if cmds.window(self.window, exists=True): self.deleteUI() # rampアトリビュート用Nullを作成 cmds.group(em=True, n=self.nodeName) createRampAttrbute( self.nodeName, self.rampName ) # ウィンドウ作成 self.window = cmds.window( self.window, t=self.title, w=self.width, cc=self.deleteRampNode ) cmds.columnLayout() # Layout Frame Range rampLayout( self.nodeName, self.rampName ) cmds.showWindow( ) def createRampAttrbute( nodeName, rampName ): """ createRampAttrbute RampAttrbuteを設定します。 Args: String nodeName : RampAttrbuteの追加するノード名 String rampName : RampAttrbute名 """ cmds.addAttr( nodeName, ln=rampName, at='compound', nc=3, m=True) cmds.addAttr( nodeName, ln='ramp_Position', at='float', p=rampName, dv=-1) cmds.addAttr( nodeName, ln='ramp_FloatValue', at='float', p=rampName, dv=-1) cmds.addAttr( nodeName, ln='ramp_Interp', at='enum', en='None:Linear:Smooth:Spline', dv=1, min=0, max=3, p=rampName) cmds.setAttr( '{0}.{1}[0]'.format(nodeName, rampName), 0, 1, 2) cmds.setAttr( '{0}.{1}[1]'.format(nodeName, rampName), 1, 1, 2) def rampLayout( nodeName, rampName ): """ rampLayout rampをレイアウトします。 Args: String nodeName : RampAttrbuteの追加されているノード名 String rampName : RampAttrbute名 """ mel.eval('if (! exists("AEmakeLargeRamp")) source AEaddRampControl') mel.eval('AEmakeLargeRamp("{0}.{1}", 0, 0, 0, 0, 0)'.format(nodeName, rampName)) if __name__ == '__main__': rampWindow.showUI()解説

- レイアウトを行う前に、GUIで使用するRampのパラメータを保持する為にNullを用意しています。 そのNullにRampアトリビュートを追加します。

# rampアトリビュート用Nullを作成 cmds.group(em=True, n=self.nodeName) createRampAttrbute( self.nodeName, self.rampName )

- ウィンドウを用意し、Rampをレイアウトします。

mel.eval('if (! exists("AEmakeLargeRamp")) source AEaddRampControl') mel.eval('AEmakeLargeRamp("{0}.{1}", 0, 0, 0, 0, 0)'.format(nodeName, rampName))

- AEmakeLargeRamp コマンド。引数が6個必要ですが、rampのアトリビュート名を指定すれば、後は0で問題ないと思います。

AEaddRampControl.melglobal proc AEmakeLargeRamp( string $nodeAttr, int $bound, int $indent, int $staticEntries, int $staticPositions, int $adaptiveScaling )おまけ

実行ボタンを起動しランプの値をとる際には、Fit関数を用意すると便利です。

この関数で、パラメータの「開始値1・終了値1」間の変化を、「開始2・終了2」間の変化にマッピングします。

HoudiniのVEXライクな関数を作ってみました。def fit(parameter, startValue1, endValue1, startValue2=0, endValue2=1): """ fit 値の範囲を別の値にマッピングする。 Args: Float parameter : パラメータ Float startValue1 : 開始値1 Float endValue1 : 終了値1 Float startValue2 : 開始値2 Float endValue2 : 終了値2 Returns: Float value : マッピングされたの値 """ if parameter < startValue1: parameter = startValue1 if parameter > endValue1: parameter = endValue1 Span1 = endValue1 - startValue1 Span2 = endValue2 - startValue2 rate = float( parameter - startValue1 ) / Span1 value = startValue2 + ( rate * Span2 ) return value参照

ryusas/test_falloffCurveAttr.py

https://gist.github.com/ryusas/699ad3f5fa8469a00e8df4b3672aa89f

Maya Python Advent Calender 2020の4日目は、it_ksさんの記事です!!

- 投稿日:2020-11-30T20:44:04+09:00

Pythonで〇〇が立った!〜scipyで慣性モーメント最小化問題を解く〜

teratailの質問回答で、図形が立つとは何ぞや、という質問に答えてみましたので、一般化して記録しておきます。

皆さんおなじみの左のような絵、走っている状況であるのと漫画風のデフォルメが効いているので、自然に感じます。しかし、真ん中のように2値化してみると、漫画効果が薄れて、なんだかバランスが悪く、倒れてしまいそうに感じます。それを、右のように「立たせる」ための角度を、理論的に求めて、立たせてみよう、という試みです。

アイデアは次のようなものです。

- まずは図形の重心が中心になるように並行移動する

- そのあと、中心を軸に回転させて、最も「バランスよく立った」状態にする

- 「バランスよく立った」を、中心縦軸を固定して「まわした」時の慣性モーメントが最小になる、と定義する

慣性モーメントを最小化することで、左右をなるべく縮めた位置が求められます。結果的に図形が「立つ」ことになります。フィギュアスケートの選手が、腕をたたむことで、安定して高速回転できるのと、原理は同じです。

重心を求めること、並行移動、回転、目的関数の最小化にはPythonの数値計算ライブラリであるscipyの関数を使いました。scipyの勉強にもなりますね。目的関数である慣性モーメントを算出する部分のみnumpyで手作りしました。なお、上の図はレイアウトの関係上縦長の枠にしていますが、実際に計算した図形は、回転してはみ出さないように、ほぼ正方形を枠としています。

以下がコードです。-14.12度ほどの回転をさせることで、気持ちよく「立たせる」ことができました。

import numpy as np from scipy import ndimage, optimize import matplotlib.pyplot as plt import cv2 # 画像読み込みと2値化、白黒反転 img = cv2.imread('sample.jpg', 0) _, img = cv2.threshold(cv2.bitwise_not(img), 1, 1, cv2.THRESH_BINARY) # 平行移動して重心を中心にする center = ndimage.center_of_mass(img) img = ndimage.shift(img, np.array(img.shape)/2-np.array(center)) # 2値化した図形を表示 plt.imshow(img) plt.show() # 図形を立てた時の、中心軸に対する慣性モーメント # mass:縦軸ピクセル数、radius:中心軸からの左右のピクセル距離 # 慣性モーメント = Σ mass * radius^2 def inertia(img): mass = img.sum(axis=0) radius = np.abs(np.arange(-len(mass)//2, len(mass)//2+1)) if len(mass) != len(radius): radius = radius[radius != 0] - 0.5 # 中心位置の補正 return (mass * radius * radius).sum() # 回転させて慣性モーメントを測定する=最小化関数 def rotated_inertia(degree, img): return inertia(ndimage.rotate(img, degree, reshape=False)) # 最小化関数の最小値を求めることで、-90〜90度の回転時の最小慣性モーメントを得る res = optimize.minimize_scalar( rotated_inertia, bounds=[-90,90], args=(img), method='Bounded') # 最小値の時の回転角度を求める print(res.x) # 最小値の時の回転を実際に行う img = ndimage.rotate(img, res.x, reshape=False) # 「立った」図形を表示 plt.imshow(img) plt.show()

- 投稿日:2020-11-30T20:31:01+09:00

scikit-learnのr2_score関数の取りうる範囲に関するメモ

はじめに

scikit-learnでR^2を計算した結果をそのまま出力していたのだが、R^2にしてはマイナスの値が大きくない?というつっこみがあったのであらためて調べてみた。

scikit-learnのR^2(r2_score関数)定義

ソースを見てみる。

https://github.com/scikit-learn/scikit-learn/blob/0fb307bf3/sklearn/metrics/_regression.py#L499重みなどいろいろ複雑な処理がはいっているが、定義はよくある以下の数式のようだ。

1 - \sum{(y-\hat{y})^2} / \sum{(y-\bar{y})^2}ちなみに、データ数が1の場合、定義からも分かるように、後ろの項の分母が0になるため計算できない。

とりうる値

では、このr2_scoreのとりうる値について考えて見よう。

最大値は定義から1である。

最小値はということ、$y$ と$\hat{y}$ の差を大きくすれば、後ろの項の分子はいくらでも大きくできるため、ものすごく大きなはずれ値があれば、いくらでもマイナスになりそうだ。やってみよう

まずは同じ値を持つ者同士を引数に。

>>>from sklearn.metrics import r2_score >>>r2_score([1,2,3,4,5],[1,2,3,4,5]) 1.0ちょっとだけ変えてみる。

>>> r2_score([1,2,3,4,5],[1,3,3,3,5]) 0.8全然違うものにしてみる。

おっと、いきなりマイナス。>>> r2_score([1,2,3,4,5],[5,4,3,2,1]) -3.0めちゃででかいはずれ値を入れる

>>> r2_score([1,2,3,4,5],[100,4,3,2,1]) -981.5なるほど、いくらでもマイナスはとれそうだ。

おわりに

これで次回から「scikit-learnの関数の仕様です」と胸をはっていえそうだ。

- 投稿日:2020-11-30T20:28:07+09:00

Pythonで掃除Botを作成

Pythonで簡単な掃除Botを作成してみた!

経緯

弊社では週の仕事が最後の日に掃除を行います。

僕はその場所決めの担当をしています。

いつも集合してトランプを引いてもらい場所を決めるという作業が非常に効率が悪いと思っていました。

そこで今回はPythonを使用して開発しました!手順

従来

①定時になる

②集合する(なかなか集まらない)

③トランプを引く(この作業もなくす)

④担当掃除場所へ行く改善

①定時になる

②僕が

コマンドプロンプト(Windows10)で実行

実行結果をチャットツールに貼る

③集合せずにそのまま担当掃除場所へ移動コード

import random # メンバーを随時追加して下さい women = ['woman1'] members = ['man1', 'man2', 'man3', 'man4', 'man5', 'man6', 'man7', 'man8', 'man9'] if 'man1' in members: print('喫煙所の掃除担当は、○○' ) members.remove('man1') elif 'man2' in members: print('喫煙所の掃除は、△△') members.remove('man2') random.shuffle(members) print('男性用お手洗い掃除担当は、' + members.pop() + 'と' +members.pop()) members.extend(women) random.shuffle(members) # 3人減らしたmemberを取得する print('会議室担当は、' + members[0] + 'と' + members[1] + '\nゴミ収集担当は、' + members[3] + '\n掃除機担当は、' + members[4] + '\n水やり担当は、' + members[5] + '\nシュレッダーと三角コーナー担当は、' + members[6] + '\n宜しくお願いします!') # + '\n掃除休みは' + members[7] + 'と' +member[8]ぜひ参考にしてみて下さい!

- 投稿日:2020-11-30T20:11:55+09:00

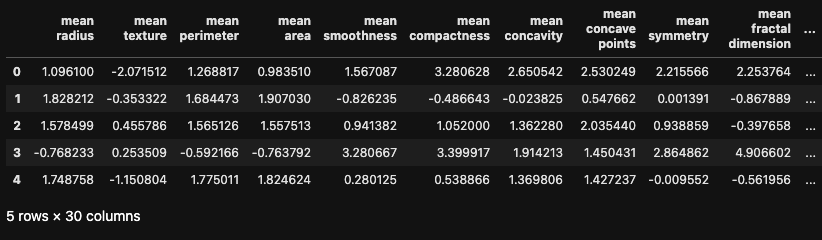

社会人2年目がデータ分析で得た教訓

はじめに

こんにちは.

NTTドコモサービスイノベーション部で働いております社会人2年目の橋本です.

業務では機械学習を中心にコードを書いています.

社会人2年目もあと残すところ4ヶ月弱となりましたが,社会人1年目から今日までデータ分析業務にて突っ走って来ました.

そんな私がこれまでを振り返るとスタート時にこれを知っておけばもっとスムーズにデータ分析を進めれただろう感じるポイントがいくつかあります.

アドベントカレンダー2日目の今日はそんな私からのクリスマスプレゼントということで「社会人2年目になった私が感じるデータ分析業務の教科書」を皆様にプレゼントしようと思います!※これ以降に出てくる内容は,難しい技術の内容は出てきません.

ただエンジニアとして働く上では大切なことも含まれていると思います.

データ分析業務に従事している方や,それ以外の技術者の方,

多くの方に読んでいただいて「わかる!あるあるだよね」と思っていただけたら幸いです.

ちなみにこれから書くことはまだ実践中で,完全にできている訳ではないです.

(わかっていても中々すぐにできるようにならないというのが私の所感です.)教訓その1.超重要!コードは誰が見てもわかるように書くべし

そもそもコードをあえて汚く書こうと思っている人なんていませんよね.

ただ何も意識しないで書くと,挙動がすぐに理解できないコードだったりすることはよくあります.

特に私の場合は

試行錯誤のフェーズ(データの中身を軽く確認する・どうやってコードに落とし込むか考える段階のこと)

でできたコードは読みにくいことが多いです.1.1 なぜコードを綺麗に書くか?

業務をしていてたまに起こるのが,

みたいな状況です. この状況は割と深刻な状況です.

過去の自分は他人のようなものなので,

自分が読みづらいと思ったコードは他人も読みづらいです.

例えばデバッグしてもらいたいと思って第三者にコードを見せると1.2 どうすればコードが綺麗に書けるか?

じゃあどうすれば読みやすいコードになるの?という疑問が湧いてくるかと思います.

詳細については,参考書籍:リーダブルコードを読むのがお勧めですが,

いくつか参考に私が実践していることを書いておきます.

- コメントでどんなプログラムか書く

データ分析をする際はjupyter-notebookを使用することが多いです.

精度向上のためにmodelを複数作る場合などがありますが

後でコードを見るとどんな特徴量を付け足し・削除をしたのか一々コードを確認しないといけなかったり,

なぜその特徴量を付け足したかなどの自分の思考プロセスを思い出せないことがあります.

このようなことを避けるため,一番上のセルになぜ・どんなことをしたのか書いておいて識別できるようにしています.なるべくネストは使わない

試行錯誤的にコードを書いていくと,過去の私が作成したif文の中に更にifを分岐させて…みたいな状況がよくあります.

作業している私からするとごく自然な流れでifが二重になるコードを生成しているのですが,

このようにしてコードを書くと未来の私がとても苦しみます.ドキュメントを書く

どのコードがどんな動きをするコードなのか書いてまとめましょう.

ディレクトリの構造も書いておいた方が後々の自分が助かります.社会人1年目の頃はコードは試行錯誤のフェーズで書いたらそのままにしてしまうことが多かったですが

試行錯誤のフェーズから相手にコードを見せるフェーズに移る前にコードをわかりやすく書き換えるのが基本です.

大切なことは「とにかく一目見たらどんなコードがなんとなくわかるコードにする」ことです.

※勿論試行錯誤のフェーズでそのままにしていたのは,サボっていた訳ではなく

コードを綺麗にすることの価値がきちんとわかっていなかったので,別のことに時間を使ってしまっていた.というのが正しいです.

ただ時間はかかってもコードをわかりやすく整理しておくことはかなり重要なので

生産性向上のため絶対にやったほうが良いです.教訓その2.メモリや計算時間には気を遣うべし

データ分析をしていると,必然的に大きなデータを扱うことが多くなってきます.

などに悩ませられることがあります.

2.1 tqdmを用いて処理時間を目視で確認しよう

まずforループを回すときや,大きなデータを読み込むときには

tqdmを用いてプログレスバーを表示させるようにしましょう.tqdm は進捗を目視で確認できる便利なモジュールです.

from tqdm import tqdm for i in tqdm(range(100)): ...このような形で簡単にforループ内に組み込むことができます.

100%|██████████| 100/100 [00:00<00:00, 273066.67it/s]2.2 適材適所のデータ構造を使うべし

python にはlistやdict,setなど様々なデータ構造があります.

普段pythonを使い慣れている方でも,きちんとドキュメントを読んだことがない方も居るかもしれません.

一度目を通してみると新しい知見があって面白いです.業務ではlistを使用してしまうことが多いですが,

listだと処理が重く,遅くなってしまうことも多いのでsetなどが使えないかどうか考えてみると良いです.小ワザとして,listを用いてappendを行う場合は

forベタ書き→リスト内包表記を行うことで多少は高速になります.

また,大きな疎行列などを扱う際にはscipyを使うなど工夫をしてあげると良いです.2.3 chunksizeを使って大きなファイルを読み込む

あまりにもファイルが大きくて

df = pd.read_csv('img_data.csv')このような形で読み込んでも時間がかかる場合は

df = pd.read_csv('img_data.csv',chunksize='500')のようにしてファイルを読み込むと良いです.

教訓その3.最強のチームを目指し個人のスキルを向上すべし

データ分析の仕事は,比較的属人化しやすいです.

そのため,個人のスキルが高ければそれで充分だと感じる人も多いかもしれません.3.0 属人化って何?

属人化という言葉を知らない人のために,念のため記載しておきます.

weblio より抜粋企業などにおいて、ある業務を特定の人が担当し、その人にしかやり方が分からない状態になることを意味する表現。多くの場合批判的に用いられ、誰にでも分かるように、マニュアルの作成などにより「標準化」するべきだとされることが多い。企画・開発業務など、属人化されているのが一般的と言われる業務もある。

上記にあるように,属人化という言葉は批判的に用いられることが多いようです.

あくまで個人の見解ですが,属人化と標準化はバランスが大切であり,どちらに傾きすぎても良くないと考えています.

3.1 なぜ属人化しやすいの?

データ分析の仕事は,仕事の性質上属人化が起こりやすいと考えています.

データ分析の大まかな流れは,

1. ビジネス課題からデータ分析できる課題に落とし込む

2. どんなデータが使えるか考える

3. データ基礎分析

4. 特徴量生成

5. モデル作成

6. 精度確認

7. 精度向上のため4.5.6.を繰り返すこのような一貫した流れで仕事をすることが多いです.

基本的に上記のタスクを一人でこなしていくことが多いと思います.

1.2.の部分は比較的チーム内で相談しやすいかなと思いますが

3.以降はやはり一つのデータについて詳しくなっていってしまうので,一人で行うことが多くなります.3.2 属人化のメリット・デメリット

上述したように,属人化と標準化は対義語にあたるものですが,どちらかであればいいというものではなくバランスがとても大切です.

属人化のメリット

- 自分のペースで働くことができる

- 責任感をもち一人一人が働く

タスクが個人に紐づいているので,

標準化で起こりがちな”だれかにタスクをなすりつける人が出てくる”ということは少ないです.属人化のデメリット

- 異動などによるチームメンバーの欠如によってアウトプットに大きな差が出てしまう

チームのメンバーによってアウトプットが異なってしまうので,割と致命的な属人化のデメリットです.

できるだけアウトプットに差が出ないように対策をしておいた方が良いと思います.- 引継ぎに時間がかかる

- ミスに気付きにくい

社会人1年目の時に特に不安だったことの一つです.

自分が何かミスしても自分しかわからないのでいつも最悪の場合を想定し,慎重に作業は行っています.- きちんと作業しているか不透明

タスクが個人で紐づいているので,他人の作業については何をしているかよくわからないこともありますが

基本は相手を信用して作業をしているだろうと思っています.

3.3 どんなスキルが必要か?

タスクの流れは3.1でなんとなくわかったかなと思うので,

3.2ではデータサイエンティストとして必要なスキルを紹介します.

業務で必要なスキルは割と幅広く,

社会人として他の業種でも必要な論理的思考力やプレゼン力,タイムマネジメントから

専門的なものまであると感じています.

データサイエンティストはコーディングについては

python(特にPandasなど)やSQLなどを用いることが多いです.

深層学習も扱うので深層学習系のライブラリも使えると良いかなと思います.データサイエンティスト協会から

スキルチェックリストなども出ているようですのでぜひ参考にしてみてください.

3.4 チームで働く意義

教訓その1で書いたようにチーム内でコードを見せ合うこともありますし,

それぞれ持っているバックグラウンドが少しずつ異なるので,詰まった時にアドバイスをもらうことも多いです.

またチーム内では,急病や異動などによって急遽人が抜けてしまうことが考えられます.

その際にあるタスクを一人でこなしていて,必要なドキュメントやコードだけ置いていかれてしまうよりも,

日頃からチーム内でのメンバーである程度やっている内容やコードなどを理解していた方が

メンバーが欠如した際の立て直しが早く,

僅かではありますが属人化を防ぐことができます.またチームで仕事をすると,様々な考え方やスキルを持った人が増えるので

一人だけで作業をするよりも良いアウトプットを出せるようになると考えられます.教訓その4. 新しい技術のキャッチアップをすべし

4.1 なぜキャッチアップするの?

キャッチアップが必要な理由は大きく分けて二つです.

- 技術の進化スピードが速い

機械学習の分野は,技術の進化のスピードがとても速いので,新しい技術のキャッチアップは欠かせません.

- チーム内での個性の確立

3章でもチームについて触れましたが,

チームで仕事をこなす際には,多様性が重視されます.

これはデータサイエンティストなどの括りではなく,世間一般的にそうであると考えます.

考え方のみでなく,スキルセットも多様性に富んでいるほうが

チームはより素晴らしく洗練されたものになります.

3章で述べた基本的なスキルセット+αによって個人の地位を確立すると

チーム内での存在意義を感じられて仕事をしやすくなります.しかし新入社員や経験が浅い人が,すぐにチームで個性を発揮できるほど,

ある一つの分野に精通しプロフェショナルになるのは難しいです.もちろん先輩と同じ分野で先輩以上のスキルを身に付けられるのであれば何も問題ないですが,

そうなるには膨大な努力と時間が必要になります.

そこで,新しい分野を取り入れるという方法が考えられます.

新しい分野であれば,先輩社員であってもあまり知らない部分も多く

先輩と同様に地位を確立できるチャンスを掴むことができます.このように,最新技術をキャッチアップし,詳しくなることで自分だけでなく,

チームとしても最強になれるのです.

4.2 キャッチアップの方法と最新技術の導入・検証について

キャッチアップの方法は人それぞれだと思います.

どの方法が正しいというのはないと思うので好きな方法で行えばいいと思っていますが,

大きな学会で発表された論文などは手堅くチェックしておくと良いかなと思います.

Google Scholarなどを用いて検索するのも良いかと思います.良さそうな最新技術を見つけたら,実際にその技術が活かせるか検証してみましょう

技術の導入検証は,つまづくことが多いです.

先輩も知らないことを取り入れようとしているので

わからない時にどうしたら良いか困ってしまうこともあるかもしれません.お勧めの方法は

1. 公式ドキュメントを参考にする

2. 公式のQuestion&Answerを参照する

3. 公式のQuestion&Answerで質問するこの流れで行っていくと良いです.

(先輩曰く大抵のことはドキュメントで解決できるらしいですが

私はドキュメントと公式のQuestion&Answerを行ったり来たりして少しずつ知見を深めていくのが好きです.)

どうしてもわからない時は,公式のQuestion&Answerで聞きましょう.※質問は英語ですることが多いですが,英語が苦手な技術者であることも想定して,

わかりやすい英語で書くか,コードを貼り付けたりすると良いと思います.最後に

いかがでしたでしょうか?

私がデータ分析をする中でつまづいた部分とそこから得られた教訓について大まかに書きました.

社会人2年目までに感じた葛藤や,つまづいた部分をできるだけわかりやすく書いたつもりです.

これからデータサイエンティストを目指す方,エンジニアとしてコードを書く方,チームで仕事をする方など幅広い人に読んで貰えたら嬉しい限りです.

- 投稿日:2020-11-30T19:37:29+09:00

Platypus(遺伝的アルゴリズム)で整数と実数を一緒に使う魔法の呪文

Platypusで整数と実数を同時に使うと

Platypusで、整数を使う時はInteger、実数を使う時はRealを使って設定をしますが、両方を一緒に使うと次のエラーが出ます。

PlatypusError: must define variator for mixed typesなんか、

variatorを定義しなさいと言うのですが、日本語のサイトには情報がありません。皆さんどちらかだけを使った例を書いています。

でも、実際には、整数と実数が混ざって使いたいことはよくあると思うのですが、エラーが出てどうしようもありません。Platypusに書く魔法の呪文

いろいろ探していたら元々の

Githubの英語のサイトに答えがありました。https://github.com/Project-Platypus/Platypus/issues/31

いろいろ書いてあるのですが、たぶんこれを

algorithmの中に書くだけで動くようです。

variator=CompoundOperator(SBX(), HUX(), PM(), BitFlip()これで、整数と実数が使えるようになります。

このプログラムは、そこのサイトにあったプログラムです。

from platypus import * def mixed_type(x): print("Evaluating", x) return [x[0], x[1]] problem = Problem(2, 2) problem.types[0] = Real(0, 10) problem.types[1] = Integer(0, 10) problem.function = mixed_type algorithm = NSGAII(problem, variator=CompoundOperator(SBX(), HUX(), PM(), BitFlip())) algorithm.run(10000) print("Final solutions:") for solution in unique(nondominated(algorithm.result)): print(solution.variables, solution.objectives)

- 投稿日:2020-11-30T18:51:56+09:00

Pythonのimport内部実装 〜複雑怪奇なimportlib内部実装へようこそ〜

Pythonその2 Advent Calendar 2020 8日目の記事です。よろしくおねがいします。

記事の趣旨と対象読者

Pythonのプログラムを書くときに必ず登場するのが、以下のようなimport文です。

import numpy as np一見、JavaScript ES Modulesにおけるimport文

import randomSquare from './modules/square.js';に似ているようにも思われるのですが、実はPythonにおける

import文は、Pythonがインタプリタ言語であることと相まって、他の言語と比べて非常に複雑な動作をします。その仕組みを、CPythonインタプリタや標準ライブラリのソースコードまで遡って調べるのがこの記事の趣旨です。この記事は以下のような人には役立つかもしれません。

- CPythonの内部実装に興味がある人

- プログラムの動作を詳しく調べる方法を知りたい人

- Python標準のモジュールローダを上書きして、独自のモジュールローダを実装したい人

また、以下のキーワードについても記事中で説明します。

import文,__file__,_import(),sys.path,sys.path_hooks,sys.meta_path,sys.sys.path_importer_cache注意 本文中に掲載するコードは、わかりやすさのため変更を加えています。

解説の流れ

本稿では、実際のCPythonでのimport文の実行の様子を、以下の流れで解説します。

- CPythonのコンパイル部分(ソースコードからバイトコードの生成)

- CPythonのバイトコード実行部分

- Pythonで記述された関数

__import__の実行部分__import__がモジュール名解決のために使用するFinder, Spec, Locatorについて

import文Pythonでは、

import文を用いることにより、モジュールを読み込むことができます。import my_moduleモジュールの多くはファイルを実体に持ちます。(ただし以下に述べるように例外もあります。)例えば上の例では、現在のファイルと同じディレクトリ(REPL環境の場合は作業ディレクトリ)又は

sys.pathに示されたディレクトリにmy_module.pyというファイルがあるか、my_moduleというディレクトリがありその中に__init__.pyというファイルがあります1。以下のように確認できます2。import my_module print(my_module.__file__) # "/path/to/my_module.py" もしくは "/path/to/my_module/__init__.py"なお、モジュールがファイル

my_module/__init__.pyで定義されている場合は、パッケージと呼ばれます3。その場合、ディレクトリmy_module/内にファイルmy_sub.pyを配置することで、サブモジュールとして扱うことができます。# import my_module は書かなくても自動で実行される import my_module.my_sub print(my_module.__path__) # "/path/to/my_module" print(my_module.__file__) # "/path/to/my_module/__init__.py" print(my_module.my_sub.__file__) # "/path/to/my_module/my_sub.py"コマンドラインから直接実行されるモジュールは

"__main__"という名前になります。一度読み込まれたモジュールはsys.modulesに辞書形式で格納されるため、以下のようにすればコマンドラインから実行したファイル名を取得できます。import sys print(sys.modules['__main__'].__file__)import文の内部実装

バイトコードの生成

import文はCPythonによってどのように実行されるのでしょうか。

まず、CPythonは入力されたPythonスクリプトを抽象構文木に変換します。その後、抽象構文木を解釈しPythonの内部バイトコードに置き換えます。

Python/compile.c:compiler_import()において、import文を表現する抽象構文木からバイトコードを生成しています。注意 実際は、

compiler_import以外にも、compiler_from_importが存在します(それぞれ、import x,from x import yに相当)。ここではcompiler_importのみを考えます。Python/compiler.cstatic int compiler_import(struct compiler *c, stmt_ty s) { Py_ssize_t i, n = asdl_seq_LEN(s->v.Import.names); for (i = 0; i < n; i++) { alias_ty alias = (alias_ty)asdl_seq_GET(s->v.Import.names, i); int r; ADDOP_LOAD_CONST(c, _PyLong_Zero); ADDOP_LOAD_CONST(c, Py_None); ADDOP_NAME(c, IMPORT_NAME, alias->name, names); if (alias->asname) { ... } else { identifier tmp = alias->name; Py_ssize_t dot = PyUnicode_FindChar( alias->name, '.', 0, PyUnicode_GET_LENGTH(alias->name), 1); if (dot != -1) { tmp = PyUnicode_Substring(alias->name, 0, dot); ... } r = compiler_nameop(c, tmp, Store); ... } } return 1; }

stmt_ty *sはInclude/Python-ast.hで宣言された構造体で、構文木を表します。sがimport文を表す場合、s->Importに構文木の情報が入力されています。Include/Python-ast.htypedef struct _stmt *stmt_ty; struct _stmt { enum _stmt_kind kind; union { ... struct { asdl_seq *names; } Import; } v; }; ... typedef struct _alias *alias_ty; struct _alias { identifier name; identifier asname; };Include/asdl.htypedef PyObject * identifier;

s->v.Import.namesが構造体alias_tyのリストになっており、alias_tyはname及びasnameの組です。すなわち、import name1 as asname1, name2 as asname2, name3という文はstruct _alias { name: "name1", asname: "asname1" }, struct _alias { name: "name2", asname: "asname2" }, struct _alias { name: "name3", asname: NULL }のような配列として表現されています。これらの個々の要素を順に

asdl_seq_GET()を用いて取得します。

次に、ADDOP_LOAD_CONST()を用いて定数を2つ生成しています(これらはそれぞれIMPORT_NAME命令に渡されるlevel,fromlistを表しています)。またADDOP_NAME()を用いてIMPORT_NAME命令を生成します。さらに、nameが.を含んでいる場合、最初の部分のみを取り出します。これが、読み込んだモジュールを格納するための変数名となります。最後にcompiler_nameop()を呼び出し、変数を登録(普通はSTORE_GLOBAL命令の生成)しています。

IMPORT_NAME命令の実行CPythonの内部バイトコードが生成されると、CPythonはこれを実行器

Python/ceval.cを用いて実行します。Python/eval.cPyObject* _PyEval_EvalFrameDefault(PyThreadState *tstate, PyFrameObject *f, int throwflag) { ... main_loop: for (;;) { ... dispatch_opcode: switch (opcode) { ... case TARGET(IMPORT_NAME): { PyObject *name = GETITEM(names, oparg); PyObject *fromlist = POP(); PyObject *level = TOP(); PyObject *res; res = import_name(tstate, f, name, fromlist, level); Py_DECREF(level); Py_DECREF(fromlist); SET_TOP(res); if (res == NULL) goto error; DISPATCH(); } ... } ... } ... } ... static PyObject * import_name(PyThreadState *tstate, PyFrameObject *f, PyObject *name, PyObject *fromlist, PyObject *level) { PyObject *import_func, *res; PyObject* stack[5]; import_func = _PyDict_GetItemIdWithError(f->f_builtins, &PyId___import__); ... Py_INCREF(import_func); stack[0] = name; stack[1] = f->f_globals; stack[2] = f->f_locals == NULL ? Py_None : f->f_locals; stack[3] = fromlist; stack[4] = level; res = _PyObject_FastCall(import_func, stack, 5); Py_DECREF(import_func); return res; }CPythonにおける実行器の実体は