- 投稿日:2020-11-08T22:59:23+09:00

プリザンターのAPIを使ってみる(python/FastAPI)

概要

https://qiita.com/donraku/items/147fbea348657a4ffbf1

↑の内容をベースにして、今度はpythonを使ってプリザンターの「API機能」を使ってみることにしました。

pythonを使うにあたってフレームワークを採用してみました。前提条件

- プリザンター(https://pleasanter.net/fs/publishes/420234/edit)

- API

- python

- フレームワーク

- FastAPI(https://fastapi.tiangolo.com/ja/)

これらの詳細は省略。

結論

pythonを使ってプリザンターにデータ登録ができた。(APIで)

フレームワークのFastAPIはなかなか使えることがわかった。詳細

pythonのフレームワークを選定

今後の展開を考えて、フレームワークを利用することに。

ざっと調べてFastAPIが良さそうなので採用。

インストール作業などについては、省略。情報はこちら。

https://fastapi.tiangolo.com/ja/FastAPIでの開発準備

マニュアルをもとに、最小のソースを作ってWebサーバーを起動。

Webサーバーはuvicornというやつ。ソースはこちら。これだけでOK。

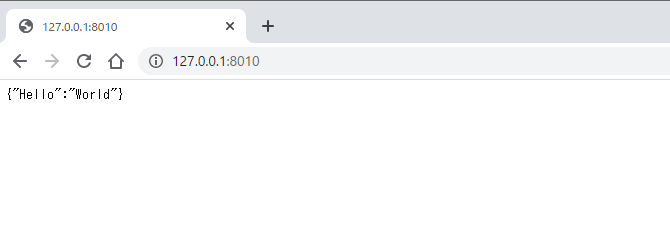

main.pyfrom fastapi import FastAPI app = FastAPI() @app.get("/") def read_root(): return {"Hello": "World"}コマンドプロンプトからWebサーバーを起動。

ポートはデフォルトだと競合したので8010を指定。

すぐ起動します。>uvicorn main:app --reload --port 8010 INFO: Uvicorn running on http://127.0.0.1:8010 (Press CTRL+C to quit) INFO: Started reloader process [26816] using statreload INFO: Started server process [22304] INFO: Waiting for application startup. INFO: Application startup complete.ブラウザで表示を確認。表示OK。

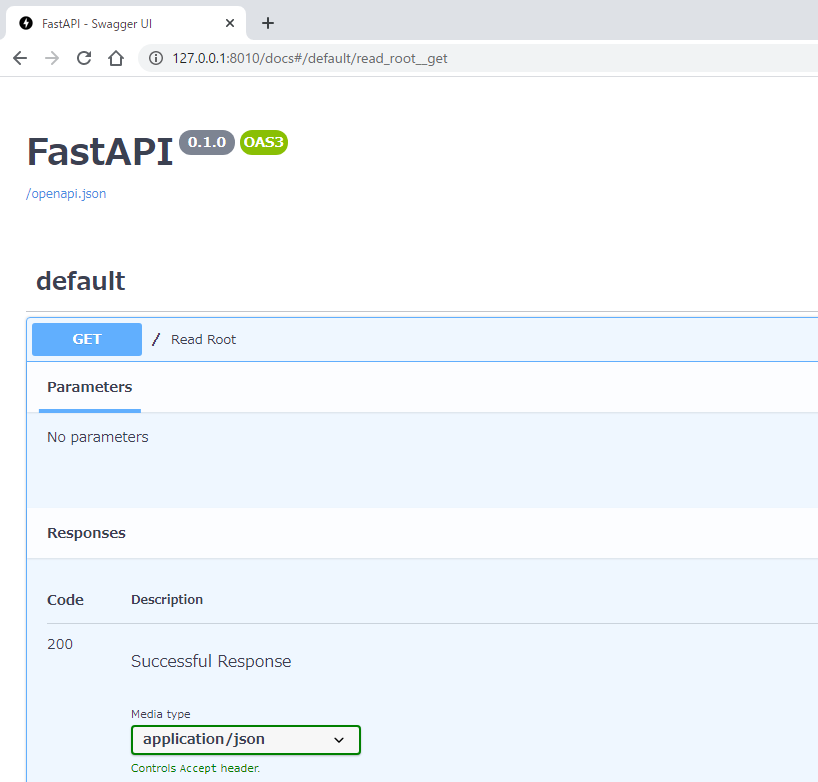

ドキュメントも勝手にできちゃう。

なかなかすごい。余談ですが。FastAPI(python)からプリザンターへ登録

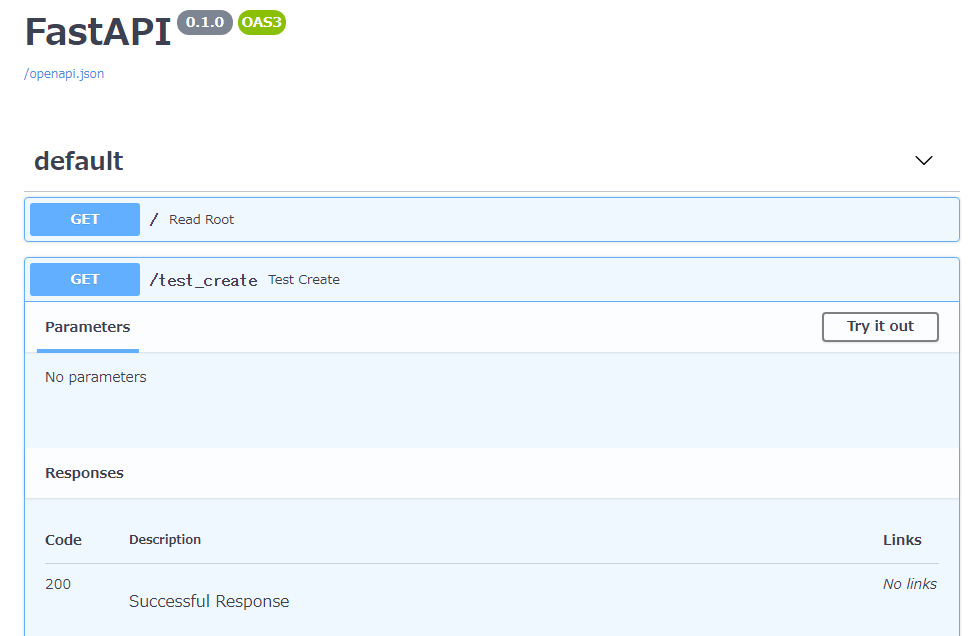

試しに「/test_create」というエンドポイントを作成して、その中でプリザンターへデータを登録するようにする。

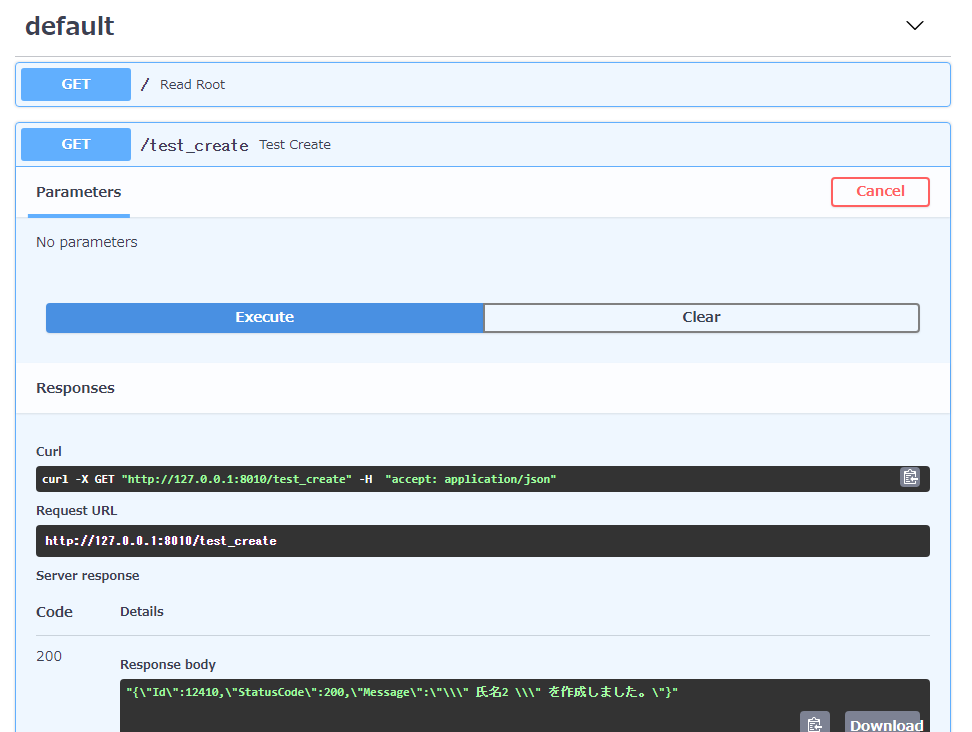

main.pyimport requests import json from fastapi import FastAPI from requests_ntlm import HttpNtlmAuth app = FastAPI() @app.get("/") def read_root(): return {"Hello": "World"} @app.get("/test_create") def test_create(): url = 'http://192.168.10.10/pleasanter/api/items/12389/create' json_str = '''\ { "ApiVersion": 1.1, "ApiKey": "ea55625bb586d27df01c281e5ef5464e4bbe6bc86d1451a24fd430351198ce0bbabc467cdd1d0ebdf4045ec22922dfce7a9f47a8241559229a7d5129d2329879", "ClassHash": { "ClassA": "氏名2", "ClassB": "所属3", "ClassC": "場所4" }, "DateHash": { "DateA": "2020/11/08 08:00", "DateB": "2020/11/08 17:00" }, "Body": "通常勤務です" } ''' json_data = json.loads(json_str) headers = {'content-type': 'application/json; charset=UTF-8'} response = requests.post(url, json=json_data, headers=headers, auth=HttpNtlmAuth('xxx\xxx', 'xxx')) return (response.text)↑のドキュメントを使って実行すると。。。

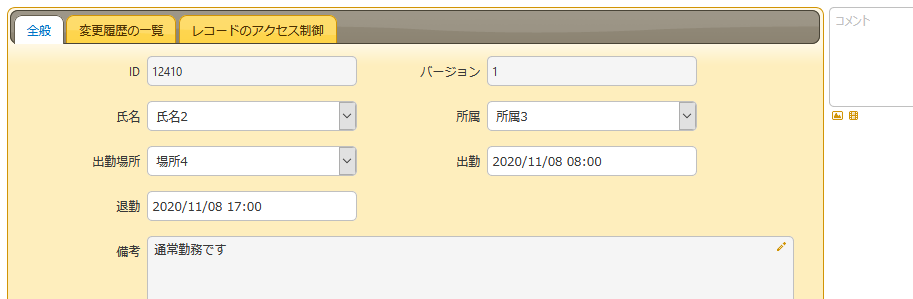

成功!!

"{\"Id\":12410,\"StatusCode\":200,\"Message\":\"\\" 氏名2 \\" を作成しました。\"}"プリザンターの画面で確認してOK!

登録できたので、ここまでで終わり。

- 投稿日:2020-11-08T22:58:13+09:00

AtCoder Beginner Contest 182 参戦記

AtCoder Beginner Contest 182 参戦記

ABC182A - twiblr

1分で突破. 書くだけ.

A, B = map(int, input().split()) print(2 * A + 100 - B)ABC182B - Almost GCD

4分で突破. 少し悩んだが全部試せばいいことに気づいた.

N, *A = map(int, open(0).read().split()) result = 0 for i in range(2, 1000): t = 0 for a in A: if a % i == 0: t += 1 result = max(result, t) print(result)ABC182C - To 3

6分で突破. 言うまでもないが、各桁の数の合計が3の倍数なら3の倍数. なので各桁の数の合計を3で割ったあまりを考えることになる. 余りが0であれば最初から3の倍数なので話はおしまい. 余りが1, 2の場合には1桁ないし、2桁消せば必ず3の倍数になるが、消せる桁数が足りているかをチェックする必要がある.

N = input() t = [int(c % 3) for c in N] x = sum(t) if x % 3 == 0: print(0) elif x % 3 == 1: if 1 in t: print(1) else: print(2) elif x % 3 == 2: if 2 in t: print(1) else: print(2)ABC182D - Wandering

17分で突破. 各ラウンドの開始時点の座標はそれまでの累積和の合計であることはすぐ分かる. 各ラウンド毎に座標が最大となるのは、ラウンドの開始時点の座標にそれまでの累積和の最大値を足したものとなるので、それの最大を取れば良い.

from itertools import accumulate N, *A = map(int, open(0).read().split()) a = list(accumulate(A)) result = 0 c = 0 m = 0 for i in range(N): m = max(a[i], m) result = max(result, c + m) c += a[i] print(result)ABC182E - Akari

60分で突破. 難しく考えすぎた. 何も考えずに色塗りすればよかった…….

from sys import stdin readline = stdin.readline H, W, N, M = map(int, readline().split()) AB = [tuple(map(lambda x: int(x) - 1, readline().split())) for _ in range(N)] CD = [tuple(map(lambda x: int(x) - 1, readline().split())) for _ in range(M)] t = [[0] * W for _ in range(H)] ly = [[] for _ in range(H)] lt = [[] for _ in range(W)] for a, b in AB: ly[a].append(b) lt[b].append(a) for i in range(H): ly[i].sort() for i in range(W): lt[i].sort() by = [[] for _ in range(H)] bt = [[] for _ in range(W)] for c, d in CD: by[c].append(d) bt[d].append(c) for i in range(H): by[i].append(W) by[i].sort() for i in range(W): bt[i].append(H) bt[i].sort() result = 0 for h in range(H): lyh = ly[h] i = 0 pd = -1 for d in by[h]: j = i while j < len(lyh) and lyh[j] < d: j += 1 if i != j: for w in range(pd + 1, d): t[h][w] = 1 i = j pd = d for w in range(W): ltw = lt[w] i = 0 pc = -1 for c in bt[w]: j = i while j < len(ltw) and ltw[j] < c: j += 1 if i != j: for h in range(pc + 1, c): t[h][w] = 1 i = j pc = c print(sum(sum(x) for x in t))

- 投稿日:2020-11-08T22:45:10+09:00

購入済みUdemy講座 (2020/11/08時点)

独学の教材として、先月頃からUdemyを使用し始めました。

自分が購入したものを以下記載していきたいと思います。

(セールでとりあえず買っておいた、という未着手のものが多々あります)そもそもUdemyとは

Udemyトップページ

Udemyの仕組みに関するよくある質問上記ページをご覧いただくとお分かりになると思いますが、動画配信のオンライン学習サービスです。

一度購入しておくと、その後期間無制限で何度も見ることができます。

"2万円"などの高額な講座もあるのですが、毎月と言ってよいほど頻繁にセールが開催され、1500円で購入できたりするので、そのタイミングでまとめ買いをするとお得かと思います。

(買って満足してしまう罠がありますが)購入した講座一覧

※購入して積みっぱなしにしないよう戒めのために公開しておきます。

★★★受講完了済み★★★

「はじめての AI」 by Grow with Google

講座内容

AI の基礎知識とその仕組みについて学習し、画像認識や音声認識について実際のデモをご覧いただきながら体感していただきます。基本知識だけでなく、事例や具体的にそれがどのような仕組みで動いているかも紹介することで、AI を活用するヒントを得ることを目指します。「AWS:ゼロから実践するAmazon Web Services。手を動かしながらインフラの基礎を習得」 by 山浦 清透

講座内容

★ゼロからAWSの重要サービスを使いこなせるように!実際にネットワークやサーバーを構築し、インフラの基礎概念を習得します。

本講座は、「はじめてAWSを学ぶ方」や「インフラにあまり詳しくない方」を対象に、「AWSの重要サービスを使い、自分でネットワークやサーバーを構築できるようになる」ことを目指したコースです。

セクションごとに、インフラの基礎概念を学びながら、手を動かし実際に構築していく、という構成になっています。

(以下略)「Git: もう怖くないGit!チーム開発で必要なGitを完全マスター」 by 山浦 清透

講座内容

★ゼロからプロのチーム開発の現場でGitを使いこなせるよう完全マスターします

こちらのコースは未経験の方でも、プロのチーム開発の現場で必要とされるGitの全てを習得することを目的としたコースです。

(略)

こちらのコースでは、まずGitの仕組みを図解でしっかりと理解していきます。

Gitってそもそも何のためにあるのか、コミットした時にどういう風にデータを保存しているのか、マージやリベースした時に何が起こっているのか、ブランチってどういう風に実現しているのか。

そういうことを仕組みから理解することで、Gitの分かりづらいコマンドを自信を持って使えるようになります。なにより、Gitを使う上でのハードルであるステージやブランチ、HEADの概念を完全に理解することができます。

その上で、実際にプロジェクトを作成しGitHubを用いながら、コマンドを実行して学んでいきます。

スキルを身につける上で、実際に作りながら学んでいくことはとても大切です。理解したものを実践することで本当に使えるスキルを身に付けていきます。

(以下略)★★★受講中★★★

「現役シリコンバレーエンジニアが教えるPython 3 入門 + 応用 +アメリカのシリコンバレー流コードスタイル」 by 酒井 潤

講座内容

このコースでは、Python3の基礎である入門コースを一通り終えた後に、今後のアプリケーション開発に役立つためのPythonのテクニックやデーターベースアクセス(SQLite, MySQL, MongoDB, SQLAlchemy, memcached, Hbase, neo4j etc)、WEB(Flask, socket, RPC etc)、インフラ自動化(Fabric, Ansible)、並列化(スレッド、マルチプロセス)、テスト(Unittest, pytest, Tox, Selenium, etc)、暗号化(pycrypto, hashlib)、グラフィック(turtle, Tkinter)、データ解析(numpy, pandas, matplotlib, scikit-learn), キューイングシステム(ZeroMQ, Celery)、非同期処理(asyncio)などのPythonを使った応用編を取り入れております。

(以下略)★★★今後着手★★★

Python

「現役シリコンバレーエンジニアが教えるPythonで始めるスクラッチからのブロックチェーン開発入門」 by 酒井 潤

講座内容

このコースではブロックチェーンの技術とPythonを用いて仮想通貨の送金システムを構築しながらブロックチェーンの根幹にある技術、考え方とその応用方法をハンズオンで学びます。

(以下略)「現役シリコンバレーエンジニアが教えるPythonでFXのシストレFintechアプリの開発」 by 酒井 潤

講座内容

今回扱うFintech技術では、日本でも人気のあるFXの自動トレードをPythonで行い、グローバルで使われているOandaサービスのAPIを使って行います。日本で人気があるという理由でFXにしましたが、FXではなくても、APIを使ってトレードするやり方さえ学べば、例えば株式や仮想通貨のトレードなどでも十分に使える技術を学ぶことができますので、FXにご興味ない方でも自動トレードが何かということを学べる講座になっております。

(以下略)「Python+FlaskでのWebアプリケーション開発講座!!~0からFlaskをマスターしてSNSを作成する~」 by N Matsumoto

講座内容

【この講座について】

Pythonの基本的な使い方、Flaskのウェブアプリケーション開発の基本的な技術、Flaskの機能の有効活用方法、サーバサイドウェブフレームワークで利用されるMVTモデル、サーバサイドのセキュリティ、テーブル設計、SNSサンプルアプリケーション開発を通じた実践的なアプリケーション開発など、PythonのWebエンジニア必修のスキルが身につきます!!

(以下略)「Python デザインパターンマスター講座~Pythonの基本文法、コーディング規約、命名規約、プログラミング技術~」 by N Matsumoto

講座内容

【この講座について】

プログラミングを勉強し、オブジェクト指向を覚えたが実際にどういう風にコードを書けばよいか。良いコード、恥ずかしくないコードというのはどういうコードなのか理解するためにこの講座を作成しました。

コーディング規約、命名規約、コードレビュー、オブジェクト指向のベストプラクティスのSOLIDの原則、デザインパターンを通じて、良いプログラムが何なのかを理解し、技術力を身に着けます。

また、デザインパターンは転職活動の面接などでも聞かれることがあり、身に着けて損のないスキルです

(以下略)「【E資格の前に】PyTorchで学ぶディープラーニング実装」 by 株式会社 AVILEN

講座内容

<概要>

ディープラーニングの実装、実務活用のイメージが沸かない、難しそう...そんなお悩みはありませんか?

当講座は、Pythonの基本文法とNumpyの知識さえあれば、誰でもディープラーニング(DL)を実装できるPyTorchの入門講座となっています。

特別な理論や数式は扱わず、まずは実装して、ディープラーニングのイメージを掴むことをゴールとしています。

AIスペシャリスト集団、株式会社AVILENの執行役員である吉川武文氏が、PyTorchによるディープラーニング実装術を公開。

当講座で扱うプログラムは全て皆様にプレゼントします、実務でもご活用ください。Go

「現役シリコンバレーエンジニアが教えるGo入門 + 応用でビットコインのシストレFintechアプリの開発」 by 酒井 潤

講座内容

このコースでは、Goの基礎である入門コースを一通り終えた後に、次世代のFintech(金融+テクノロジー)のアプリケーションとしてビットコインを自動でシステムトレードを行うアプリを開発します。

多くの言語の良い部分を取りれたGoは、コードを実行する際のパフォーマンスも良く、近年急速にライブラリも充実して来ており、シリコンバレーで多くの企業が取り入れ始めました。日本では、ドキュメントも少なく、Go言語を使う機会があまりないかもしれませんが、世界のトップ企業はすでに使い始めているため、技術レベルで世界から遅れないように今からGo始めると良いかと思います。

(以下略)AWS

「これだけでOK! AWS 認定ソリューションアーキテクト – アソシエイト試験突破講座(SAA-C02試験対応版)」 by Edutech Global , inc.

本講座は全てのIT従事者にとって必須となるAWSの基本資格「AWS 認定ソリューションアーキテクト – アソシエイト試験」を合格を目指し、そのための知識や経験を獲得できるように設計されています。

この講座を通して、AWSの知識とノウハウを獲得し、「AWS 認定ソリューションアーキテクト – アソシエイト試験」を突破しましょう!!「Ultimate AWS Certified Solutions Architect Associate 2020」 by Stephane Maarek

講座内容

Concretely, here's what we'll learn to pass the AWS Certified Solutions Architect Associate exam:

- The AWS Fundamentals: IAM, EC2, Load Balancing, Auto Scaling, EBS, EFS, Route 53, RDS, ElastiCache, S3, CloudFront

- The AWS CLI: CLI setup, usage on EC2, best practices, SDK, advanced usage

- In-Depth Database comparison: RDS, Aurora, DynamoDB, Neptune, ElastiCache, Redshift, ElasticSearch, Athena

- Monitoring, Troubleshooting & Audit: AWS CloudWatch, CloudTrail

- AWS Integration & Messaging: SQS, SNS, Kinesis

- AWS Serverless: AWS Lambda, DynamoDB, API Gateway, Cognito

- AWS Security best practices: KMS, SSM Parameter Store, IAM Policies

- VPC & Networking in depth

- AWS Other Services Overview: CICD (CodeCommit, CodeBuild, CodePipeline, CodeDeploy), CloudFormation, ECS, Step Functions, SWF, EMR, Glue, OpsWorks, ElasticTranscoder, AWS Organizations, Workspaces, AppSync, Single Sign On (SSO)

- Tips to ROCK the examDocker

「米シリコンバレーDevOpsエンジニア監修!超Docker完全入門(2020)【優しい図解説とハンズオンLab付き】」 by CS Career Kaizen

講座内容

このコースを一文でまとめると?

このコースは、アプリ開発やDevOps経験初心者の方が、Linuxの簡単な基礎(カーネル・シェル・STDIN・STDOUT・TTY)とDocker(イメージ・コンテナ・VMとの違い・Docker compose・ネットワーキング・Volume)を初心者として1から学び、コンテナ化できるデベロパーやDevOpsとしてキャリアアップを目指す方向けのコースです。「米国AI開発者がゼロから教えるDocker講座」 by かめ れおん

講座内容

Dockerの基本的な使い方から現場で役立つ応用的な使い方まで,米国で活躍するAI開発者が講師となって徹底的に解説します.

プログラミングの知識がない人でも,問題なく受講できます.Kubernetes

「米シリコンバレーDevOpsエンジニア監修!超Kubernetes完全入門(2020)【優しい図解説とハンズオン】」 by CS Career Kaizen

講座内容

このコースを一文でまとめると?

このコースは、アプリ開発やDevOps経験初心〜中級者の方が、Linuxの簡単な基礎(カーネル・シェル・STDIN・STDOUT・TTY)とDocker(イメージ・コンテナ・VMとの違い・Docker compose・ネットワーキング・Volume)をベースにして、Kubernetesクラスター上にコンテナ化されたアプリをディプロイ・構築・起動というK8sデベロパー初心者として1から学び、コンテナ化できるデベロパーやDevOpsとしてキャリアアップを目指す方向けのコースです。アジャイル開発

「現役シリコンバレーエンジニアが教えるアジャイル開発」 by 酒井 潤

講座内容

このコースでは、あらゆるレベルのビジネスプロフェッショナルが理解しやすい方法でアジャイルとスクラムの基本をカバーします。アジャイルとスクラムの基礎に関するこのコースから得られる知識を使用して、アジャイルとスクラムに適した環境を作成できます。

アジャイルとスクラムの開発方法を取り入れれば、プロジェクトが失敗するのを防ぐことにも繋がる可能があります。このAjailプロジェクト管理方法は、チームワークが特に重要であり、チームメンバー間の相互信頼を高め、対人関係を改善することもできるでしょう。

このコースは、シリコンバレーでアジャイル開発経験14年の現役エンジニアが教授いたします。アルゴリズム

「現役シリコンバレーエンジニアが教えるアルゴリズム・データ構造・コーディングテスト入門」 by 酒井 潤

講座内容

恐らく、皆さん「アルゴリズムって本当に必要なの?」っと疑問に思っている方もいらっしゃるかと思います。例えば、「実際の現場であまり使わないなー」とか、「今の仕事はWEBのフレームワークのやり方さえ覚えれば、WEBアプリなんて簡単に作れちゃうし」などなどあるとは思います。

ただ、考えていただきたいのですが、なぜあのGAFAと言われるGoogle、Apple, Facebook、Amazonが入社試験で必ずアルゴリズム、データ構造のコーディング面接があるかを考えてみてください。

皆さんもお聞きしたことがあるかもしれませんが、Google検索アルゴリズム、Tesla自動運転アルゴリズムなど世界をリードして最先端の技術革新をしている会社では、ちょっとでもコードが早くなるように、プログラマーが、最適なコードを書く必要があるのです。

(以下略)Unity(C#)

「Unity3D入門の決定版!RPG開発の基本をUnityインストラクターと共に進めるハンズオンコース【スタジオしまづ】」 by 嶋津 恒彦

【講座内容】

・Unityのインストール

・Unityの操作方法とゲームを作る基礎(コードでものを変化させる方法)

・C#プログラミングの基礎(基礎的な文法をイラストと演習問題付き)

・3Dミニゲーム開発(キャラクターを移動せさてゴールしたら終了するゲーム制作)

・3Dアニメーションの基礎(設定・Scriptによる切り替えスキル)

------ここまでが準備-------

・3DRPGの開発

・Playerキャラクターの移動と攻撃実装

・Enemyキャラクターの移動と攻撃実装

・各キャラクターの非ダメージとHP実装

・コンボとスタミナとHPゲージの演出実装「Unity ゲーム開発:インディーゲームクリエイターが教える C#の基礎からゲームリリースまで【スタジオしまづ】」 by 嶋津 恒彦

講座内容

初心者の方でもゲームをリリースできるように、講座の構成は

Unityのインストール

Unityでゲームを作る基礎(コードでものを変化させる簡単な方法)

プログラミングの基礎(ゲーム開発に必要な最低限のスキル)

ゲーム開発のテクニック(ボタンの取得やデータの保存など)

を1話完結形式で学び、基礎力をつけた後

RPGの作成

AppStore/Google Playへのリリース

に取り掛かかります。講座を終えたときには自身のゲームを実際にストアに並べることができるようになっています。「Unityゲーム開発入門:Unityインストラクターが教えるマリオ風2Dアクションゲームを作成する方法【スタジオしまづ】」 by 嶋津 恒彦

講座内容

任天堂からこの夏Nintendo Switch向けに発売されたスーパーマリオメーカー 2。ゲーム開発の専門的な知識がなくても

オリジナルのゲームが開発できることで注目を浴びています。この講座ではスーパーマリオメーカー 2のようにステージを作成するUnityのテクニックが習得できます。

また、ステージ作成だけではなくアクションゲーム開発に必要なC#・アニメーション・当たり判定など総合的なUnityの力がこれ一本で身につく完全攻略版です。

- 投稿日:2020-11-08T22:40:16+09:00

Numpyはじめて、随時更新してく

1.Numpyはじめた

Numpyの勉強を始めて引数の指定方法や使用例など調べだすと、どうしても忘れてしまうので

随時更新してメモ帳代わりにしていこうと思います。

順番やわかりやすさは二の次なので、わかりにくいかもしれませんがご了承ください

軽く調べて見たところ、Numpyは数値計算を得意とするライブラリーなので、

たくさんの計算用の関数が用意されてるらしい2.こういうのにも感動する

pythonの四則演算を+, -, *, / の4つを使って、配列の各要素に対して四則演算をしてくれるというスグレモノ

いちいち要素取り出したりせずに演算してくれる。

最近はずっとpandas触ってたので気付きませんでしたが、先輩にnumpyは覚えてしまうくらい使ったほうがいいとの勧めがあったので、色々遊びながら調べながら覚えていこうかなと思ってます3.やっていきますか

<np.array(object, dtype=None)>

array.py#np.array()でndarrayを生成 A = np.array([1,3,5,7,9]) #--->array([1, 3, 5, 7, 9]) A -= 4 #---> array([-3, -1, 1, 3, 5]) #各要素に対して4が引き算されてる。各要素に対して引き算されてるってすごいな

これにはブロードキャストとやらが関係してるらしい(後で調べます)

objectにはarray_likeという型が入るらしい。

そのarray_likeとは配列をndarrayの他、多重リストやタプルで表現したもの。

このndarrayはnがn次元配列を扱うためのクラスです

ndarrayは基本的にすべて同じ型の要素で構成されていないといけないので、

複数のデータ型を含む配列(数値型、文字列など)を処理する場合はpandasのほうが扱いやすい<np.sin>

・課題でnp.sin()使うのでついでにゆっくり調べてみた。。。

- 投稿日:2020-11-08T22:31:52+09:00

Pythonをとりあえず何とかする(0)

はじめまして。

その辺にいる会社員です。いろいろなことが欠如しているのですが、

業務でいろいろやらないといけいないため、

メモ代わりに残すことにしました。既に知っている方からすれば、薄っぺらい内容かと思います。

コーディングレベルも低いので突っ込みどころは満載かと思います。何とかするシリーズではそこは無視していきます。

質問を書く場合があります。

見つけたら教えていただけると嬉しいです。

よろしくお願いします。使用バージョン:Python 3.8.5

使用エディタ :VS Code追記:コーディング規約もいったん無視します。

- 投稿日:2020-11-08T21:43:41+09:00

静岡のGoToEat公式サイトをスクレイピング

はじめに

静岡のGoToEat公式サイトをスクレイピング、伊豆のキャンペーン対象店をリスト化する

の記事の中に

import urllib.request html = urllib.request.urlopen(url).read()検索条件の指定が効かず同じページばかり表示されてしまう事象が発生。

ブラウザで同じURLを開く場合も新規と2回目で表示内容が異なる。どうやらSessionを判断している様子。ということなので調べてみた

URLが変わる

「伊豆市」検索直後のページ

https://premium-gift.jp/fujinokunigotoeat/use_store?events=search&id=&store=&addr=%E4%BC%8A%E8%B1%86%E5%B8%82&industry=検索直後のページと戻る(1ページ目)との違いが「events=search」と「events=page」、「id=」と「id=1」でURLが変わっているみたい

戻る(1ページ目)と次へ(2ページ目)との違いが「id=1」と「id=2」なのでidがページ数とわかりました

アクセス

試しに戻る(1ページ目)のURLからスタートすると検索結果が反映されていないので表示内容が違うため

- 「伊豆市」検索直後のページのURLにアクセス

- 戻る(1ページ目)のURLにアクセス

の順番でアクセスするといけるようです

次のページのURLはheadのlinkのなかにURLが見つかりましたのでそちらを利用、

試しに検索直後のページから次のページを取得していくと「id=2」次は「id=22」次は「id=222」と

2が増えたページが返ってきます(wスクレイピング

import requests from bs4 import BeautifulSoup import time headers = { "User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64; Trident/7.0; rv:11.0) like Gecko" } with requests.Session() as s: # 全部取得する場合はサーチは不要 # url = "https://premium-gift.jp/fujinokunigotoeat/use_store" # 検索の場合はサーチページを一旦表示してからアクセス s.get("https://premium-gift.jp/fujinokunigotoeat/use_store?events=search&id=&store=&addr=%E4%BC%8A%E8%B1%86%E5%B8%82&industry=") url = "https://premium-gift.jp/fujinokunigotoeat/use_store?events=page&id=1&store=&addr=%E4%BC%8A%E8%B1%86%E5%B8%82&industry=" result = [] while True: r = s.get(url, headers=headers) r.raise_for_status() soup = BeautifulSoup(r.content, "html.parser") for store in soup.select("div.store-card__item"): data = {} data["店舗名"] = store.h3.get_text(strip=True) for tr in store.select("table.store-card__table > tbody > tr"): data[tr.th.get_text(strip=True).rstrip(":")] = tr.td.get_text( strip=True ) result.append(data) tag = soup.select_one("head > link[rel=next]") print(tag) if tag: url = tag.get("href") else: break time.sleep(3)import pandas as pd df = pd.DataFrame(result) # 登録数確認 df.shape df.to_csv("shizuoka.csv", encoding="utf_8_sig") # 重複確認 df[df.duplicated()] df

- 投稿日:2020-11-08T21:38:06+09:00

PythonとTwitterAPIで作るブログ記事自動ツイートbot

はじめに

自分の勉強用に運営している用語辞典的なブログがあるのですが、記事の数も増えてきて人様にみていただけるようになってきたので更なる発展のため、Twitterで宣伝してみることにしました。

ということで定期的に記事をツイートするBotをPython+BeautifulSoup+TwitterAPIで作ってみます。大まかな流れ

- TwitterAPIを使えるようにする

- Pythonコードを実行してツイートできるようにする

- ツイートしたいブログの全記事のURLを一覧化したページを作る

- 作成した全記事一覧ページからURLを取得し、ツイートする

- 適当なサーバーでcronを用いて定期実行されるようにする

それでは作っていきましょう!!!

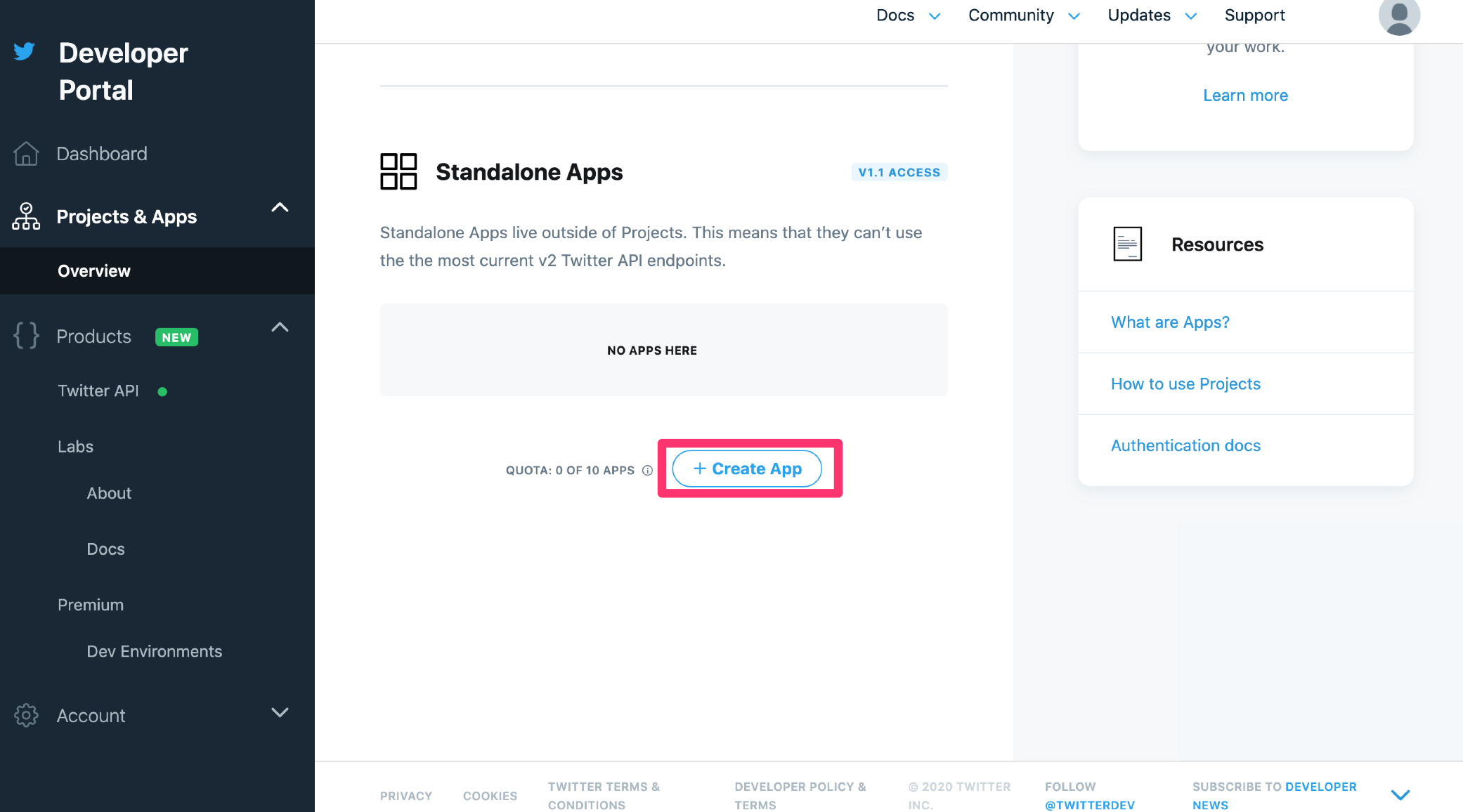

TwitterAPIを使えるようにする

Twitterアカウントを作る

Twitterアカウントを作成します。

出てくる指示に従っていけば作れます。デベロッパー申請をする

作ったアカウントに関してTwitterAPIを利用するためにデベロッパー申請をしていきます。

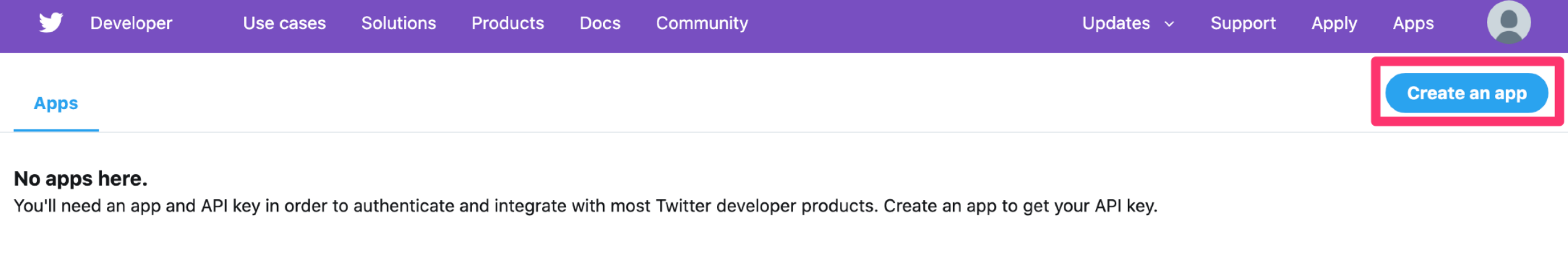

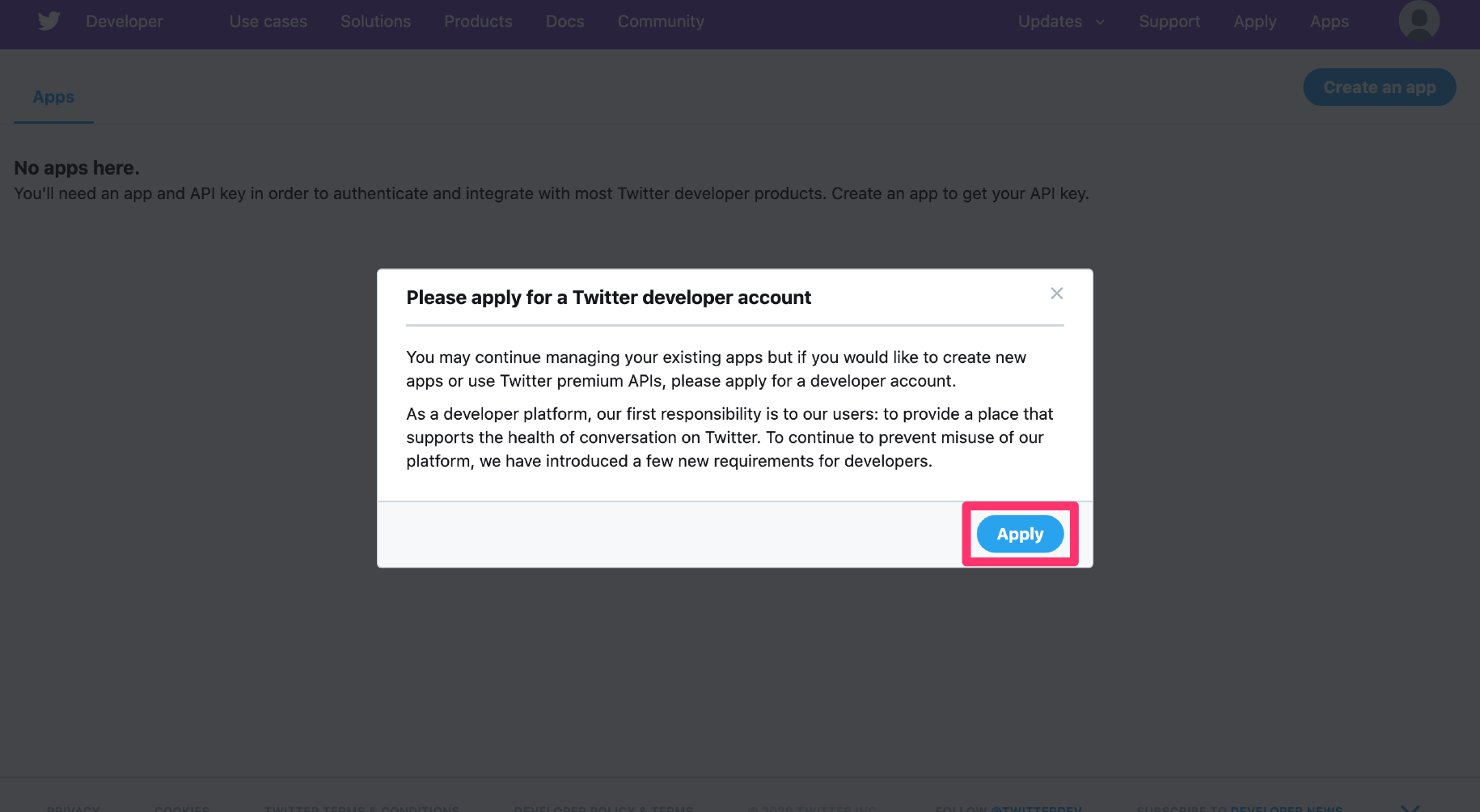

Twitterにログインした状態で、Developerサイトへアクセスします。

「Create an app」ボタンをクリック。

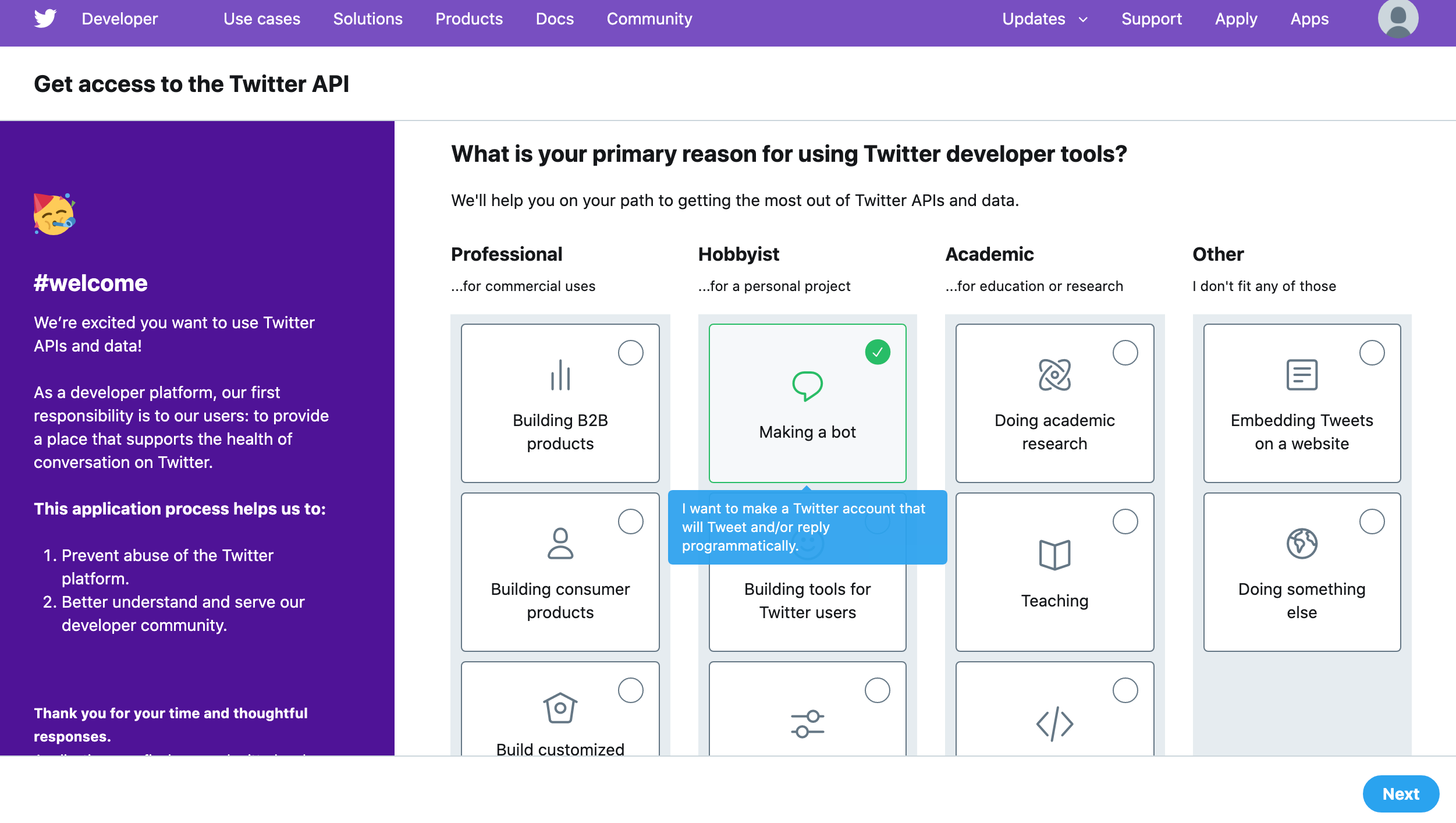

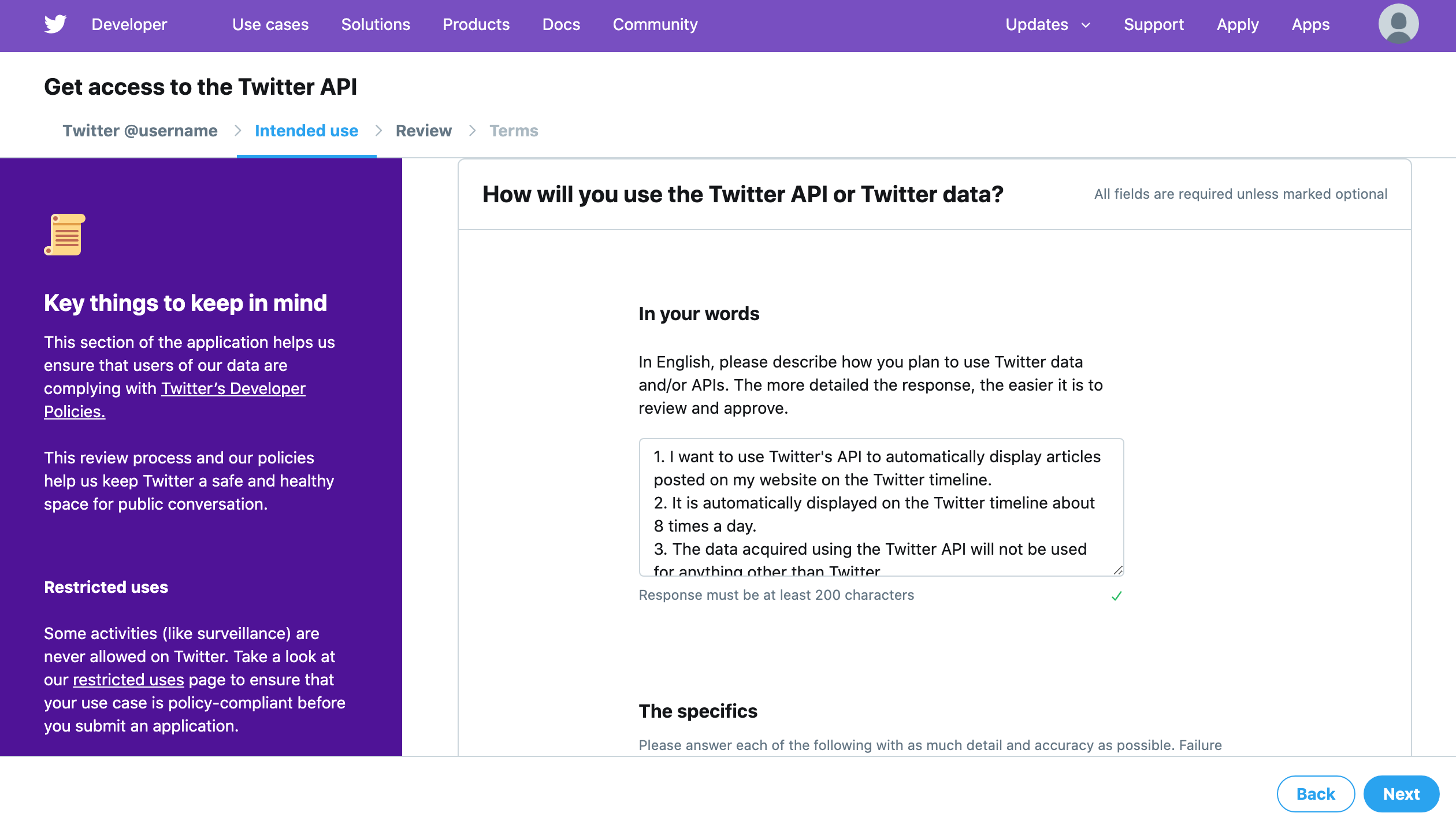

デベロッパーツールの利用目的を選択。今回はBot作成なのでMaking a botを選択。Nextをクリック。

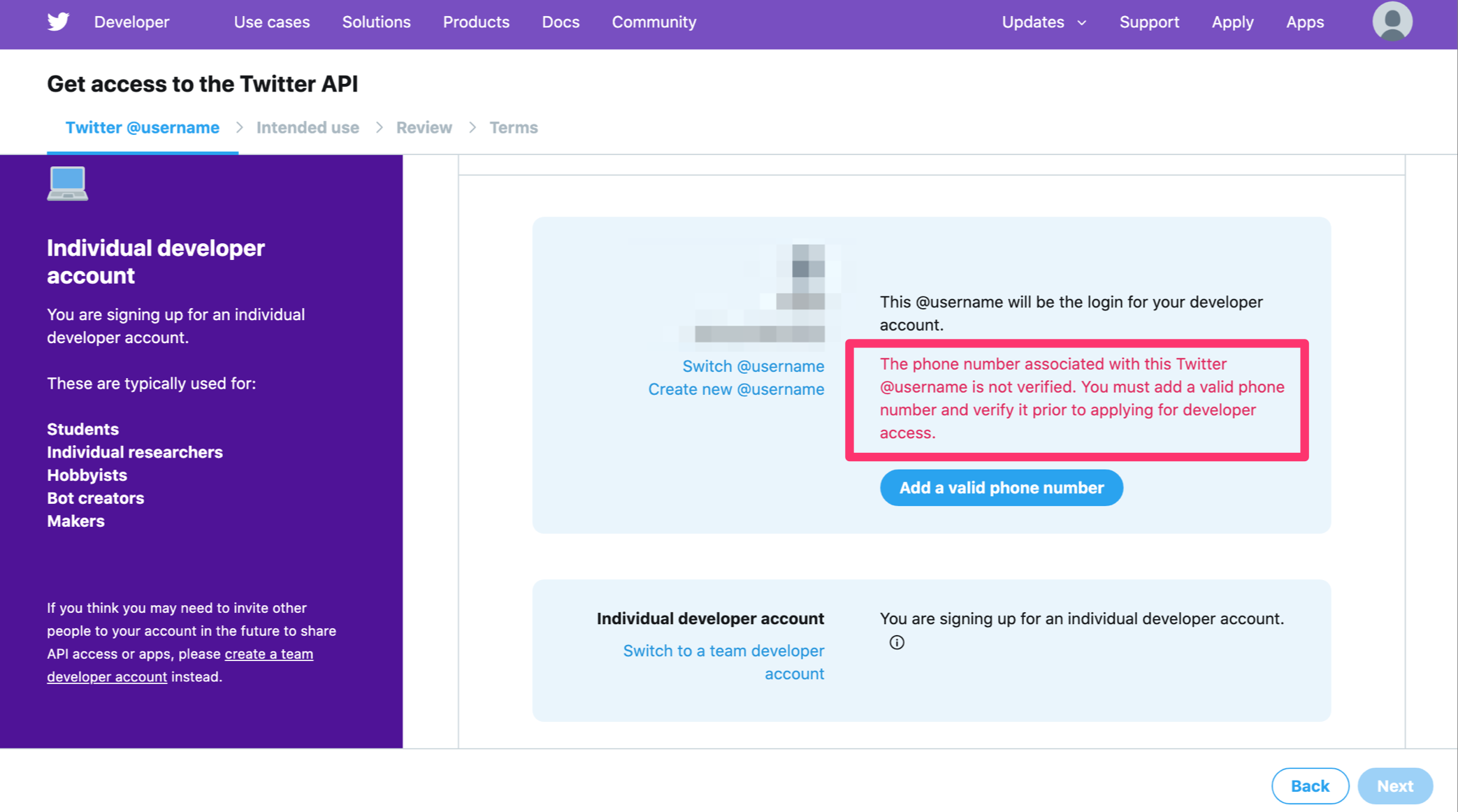

ここで電話番号認証がまだの場合は以下のように求められますので登録しましょう。

またこのページでは以下のようなことを登録していきます。

- デベロッパーアカウントのユーザーネーム

- 個人のアカウントかチームアカウントか

- 登録するメールアドレス

- 住んでいる国

- ニックネーム

- APIのアップデート情報をメールで受け取りたいか?

ぽちぽち設定していきましょう。設定を終えたらNextをクリック。

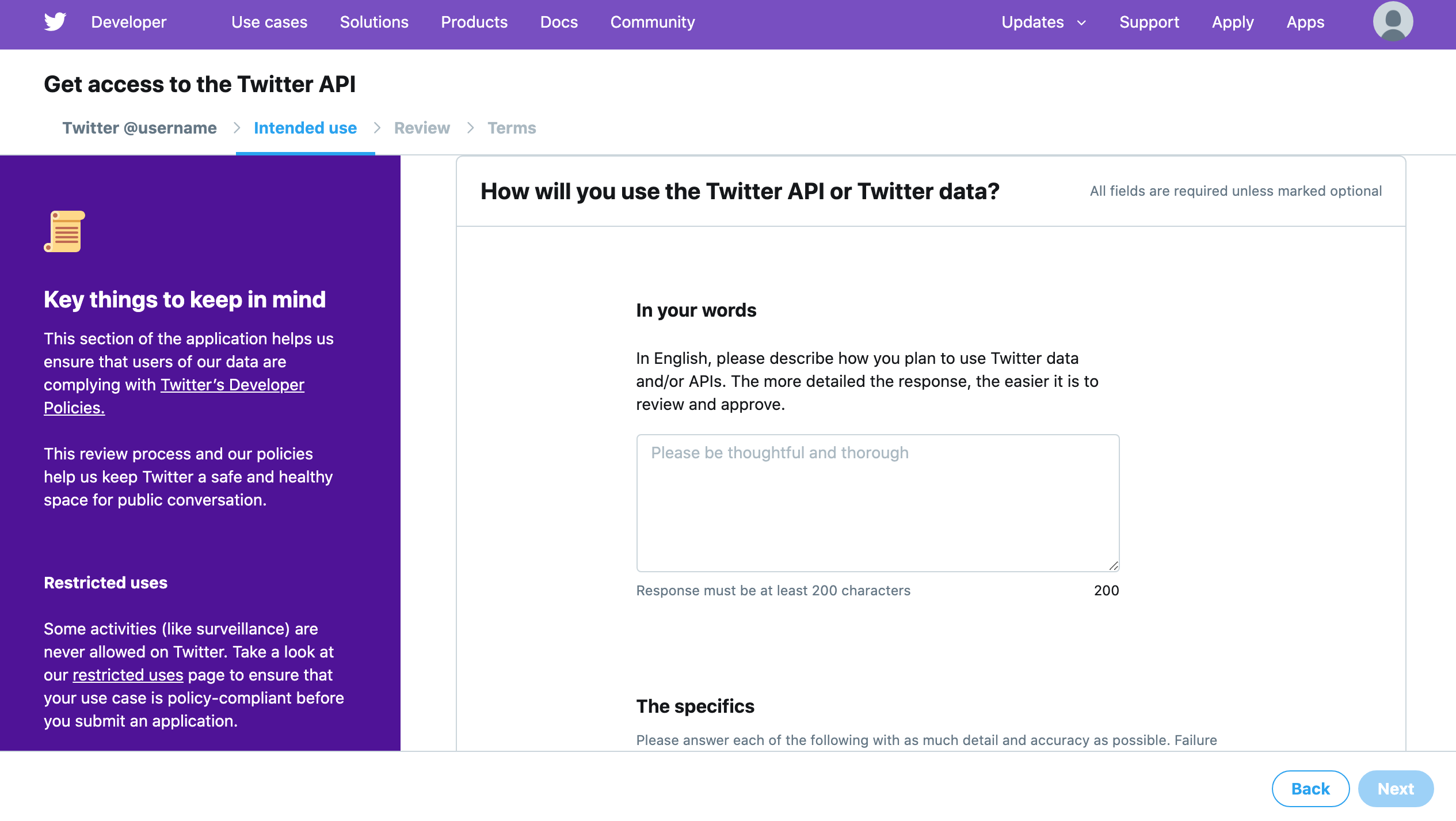

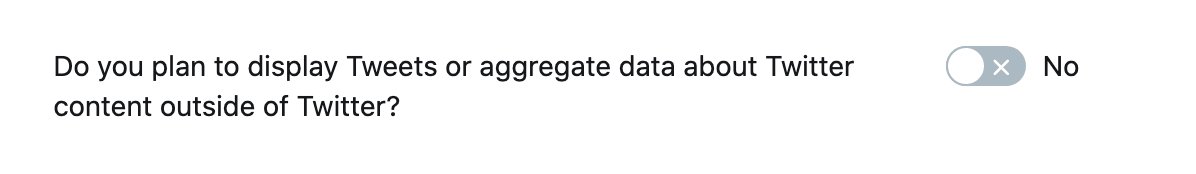

英文でTwitter APIの利用目的を回答していきます。

1つ目は「TwitterAPIと取得できるデータの利用目的を英語で教えてね!詳しく書けば承認されやすくなるよ。」といった感じに書いてあるので以下のように回答しました。・自分で作ったブログに投稿した記事をTwitterのAPIを利用して、定期的に自動でツイートしたい。 ・Twitterのタイムラインに自動的に表示させるのは1日に8回程度です。 ・TwitterAPIを利用して取得したデータをTwitter以外で利用することはありません。 #英訳 ・I want to use Twitter's API to automatically display articles posted on my website on the Twitter timeline. ・It is automatically displayed on the Twitter timeline about 8 times a day. ・The data acquired using the Twitter API will not be used for anything other than Twitter.

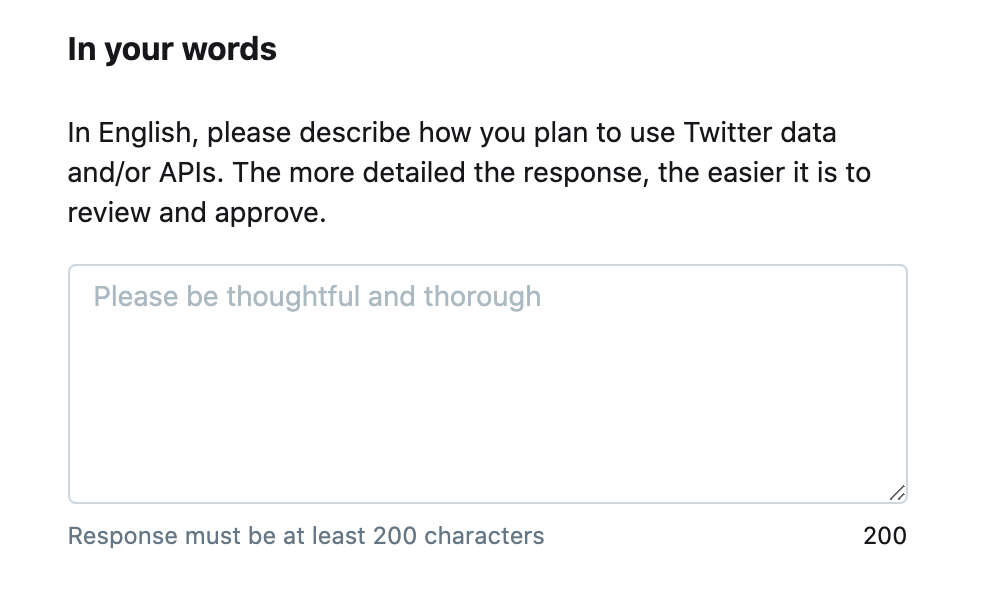

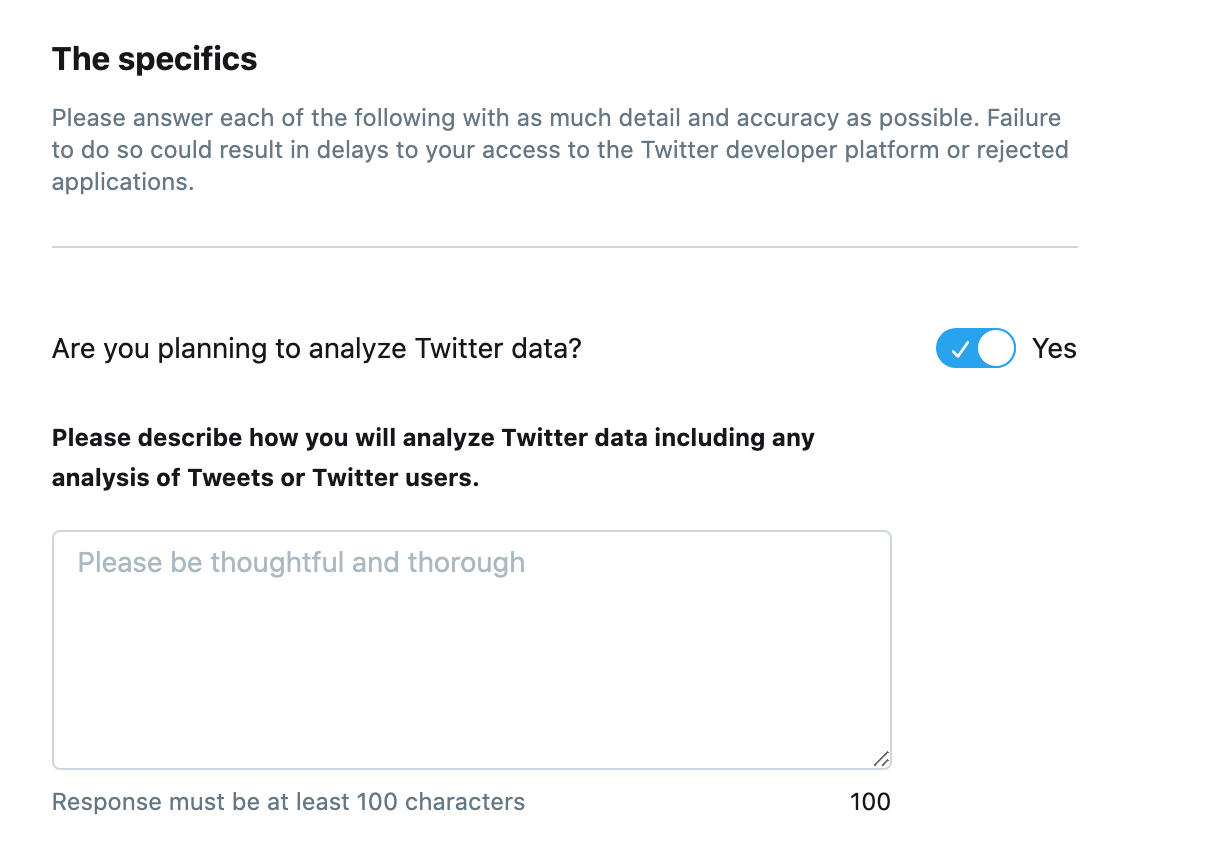

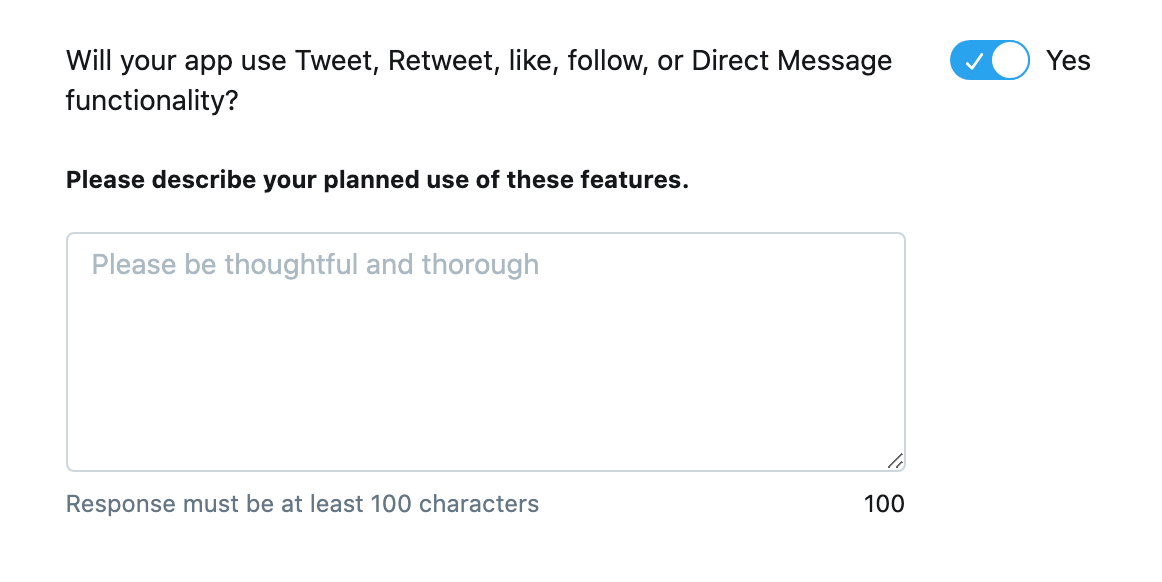

2つ目は「Twitterのデータを分析する予定ある?」といった感じに書いてあるので以下のように回答しました。自分のブログ記事を記載した自動ツイートで、ユーザーに人気のあるツイートを分析したい。 #英訳 I want to analyze tweets that are popular with users with automatic tweets that describe my blog article.3つ目は「アプリはツイート、リツイート、お気に入り、フォロー、ダイレクトメッセージを利用する?」といった感じに書いてあるので以下のように回答しました。

私のアプリは自分で作ったブログに投稿した記事をTwitterのAPIを利用して、定期的に自動でツイートしたいのでツイート、リツイート、お気に入り、フォロー、ダイレクトメッセージを利用する。 #英訳 My app uses Twitter's API to automatically tweet articles posted on my blog, so I use tweets, retweets, favorites, followers, and direct messages.4つ目は「Twitter以外でデータとかを利用する?」といった感じに書いてあり、今回は使わないので、Noにしました。

5つ目は「開発するアプリや分析結果を政府機関が利用するか?」といった感じに書いてあり、今回は使わないので、Noにしました。

ここまで入力したらNextをクリック。

入力内容の確認画面になります。入力内容に間違いがなければLooks good!をクリック。

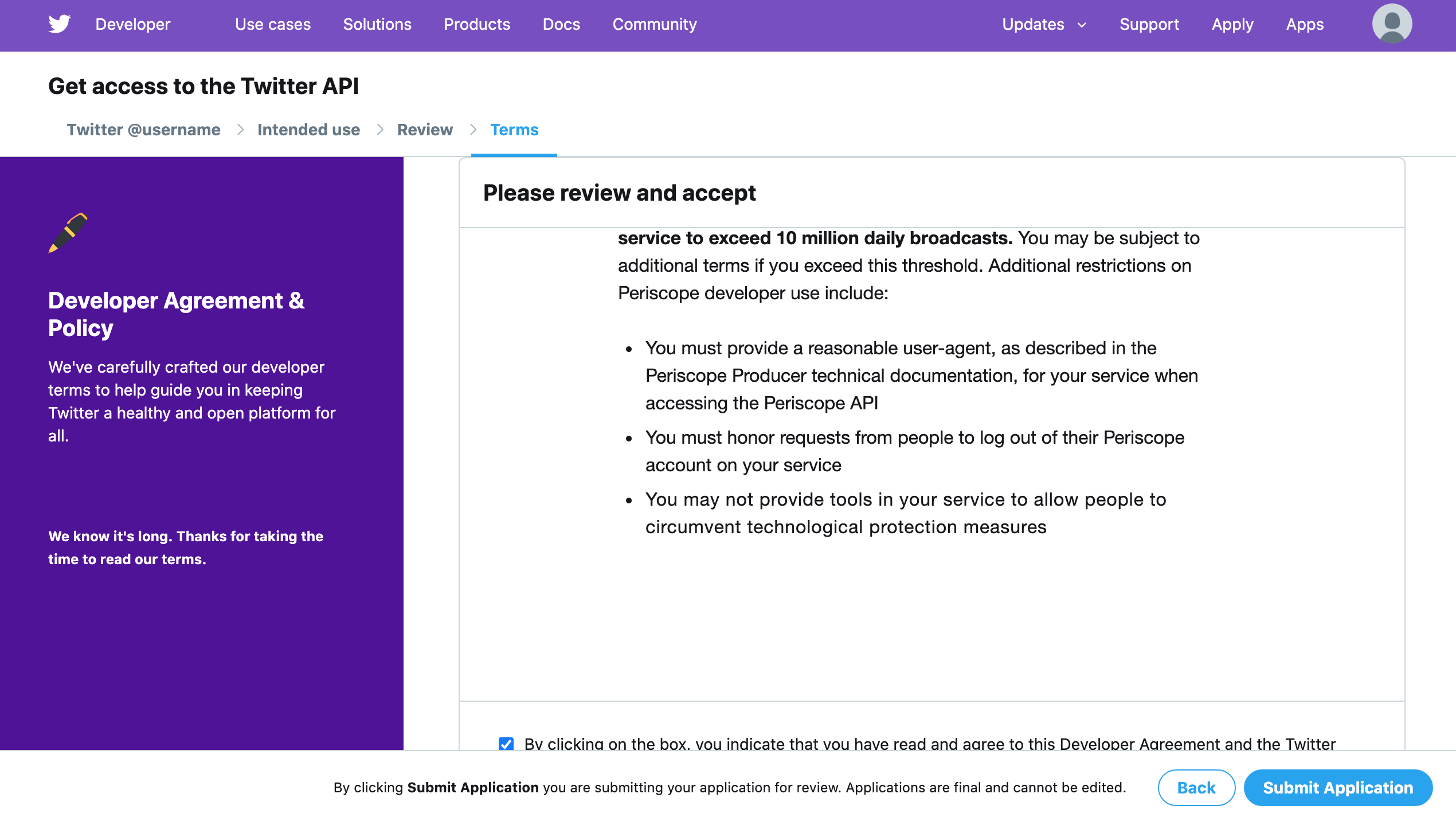

利用規約に同意して申請します。

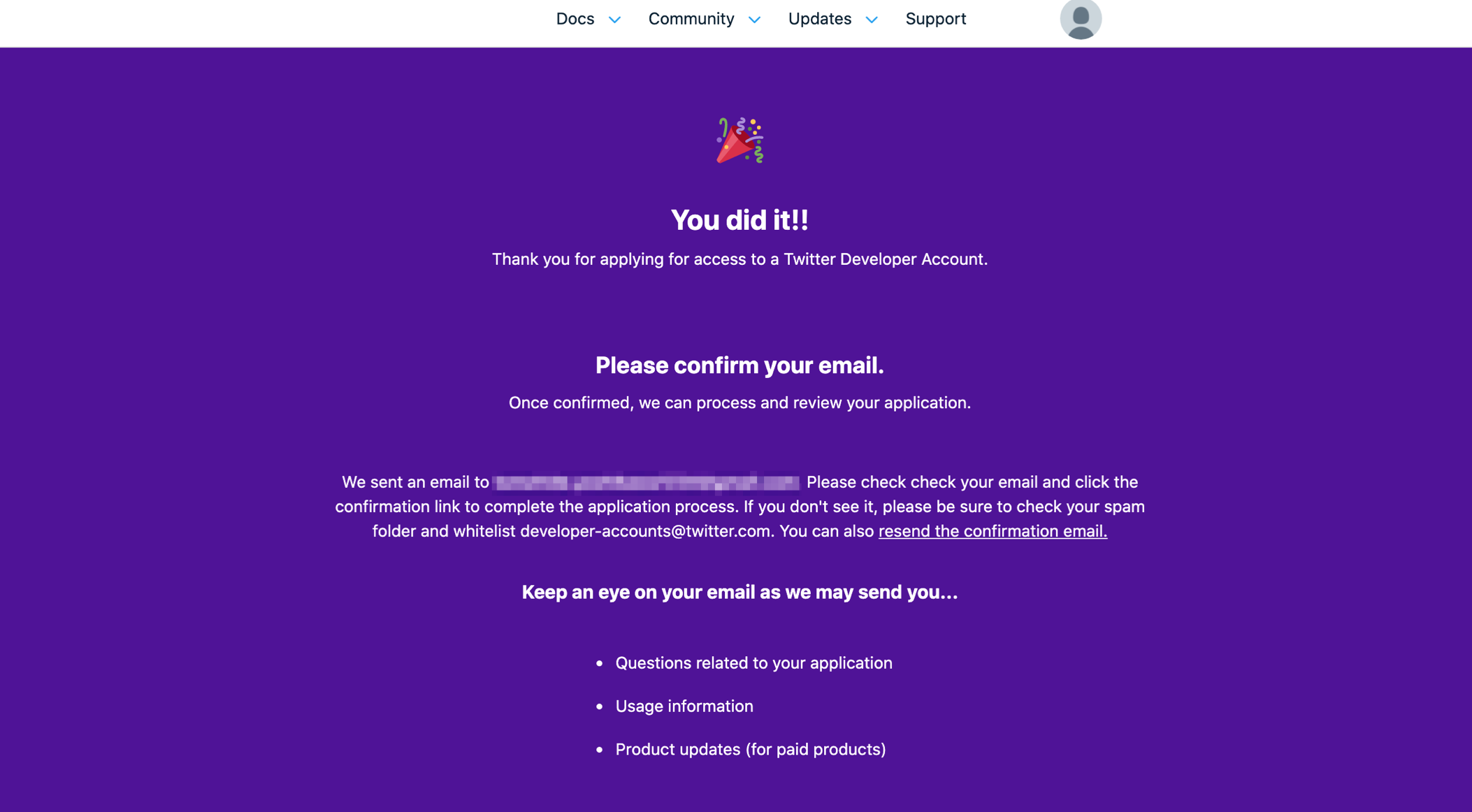

以下の画面が表示されれば申請完了です。あとは神に祈るだけ。

Twitterから以下のような本登録メールが届いているので、メールに記載されているURLにアクセスすれば登録が完了です。

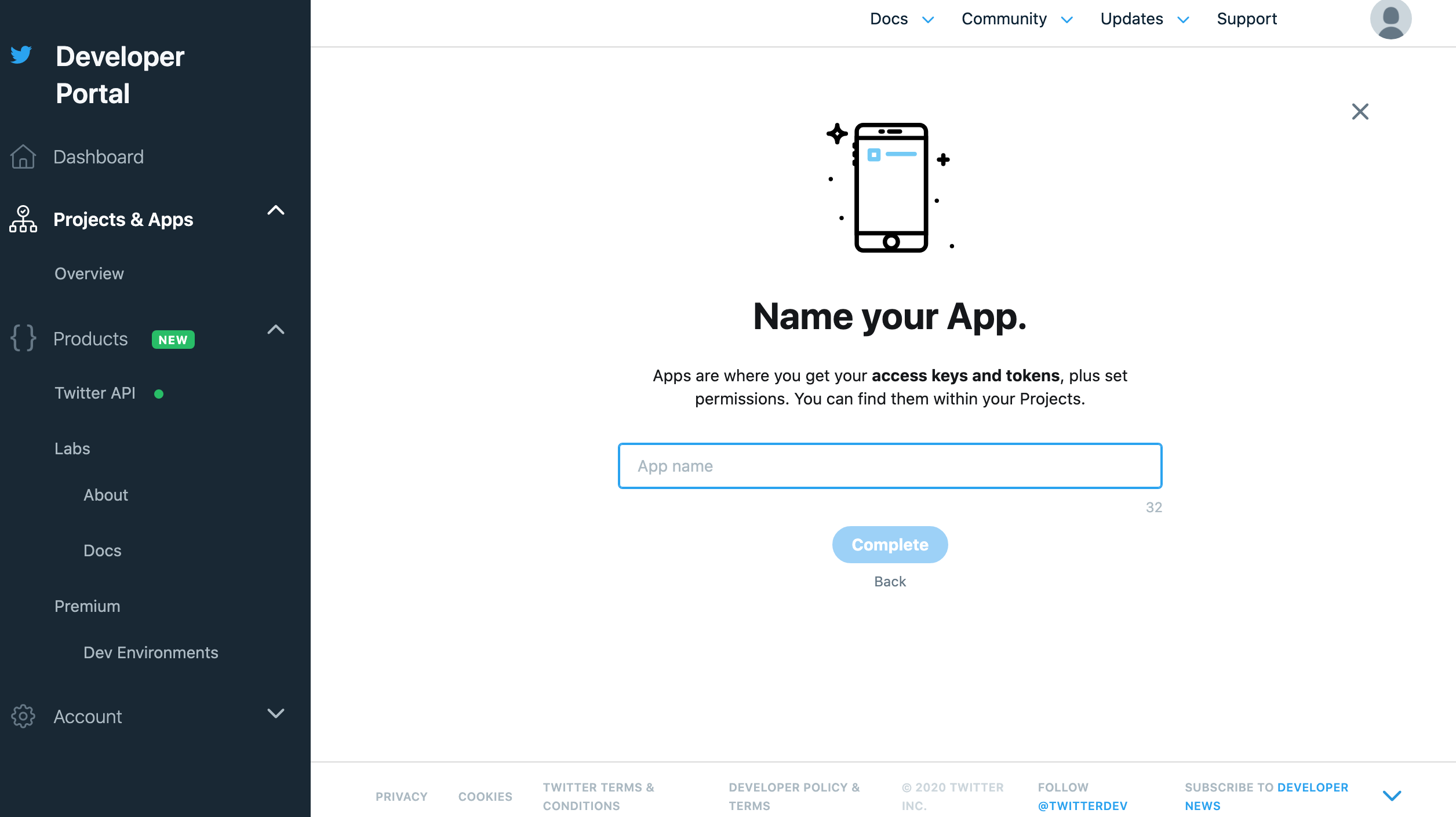

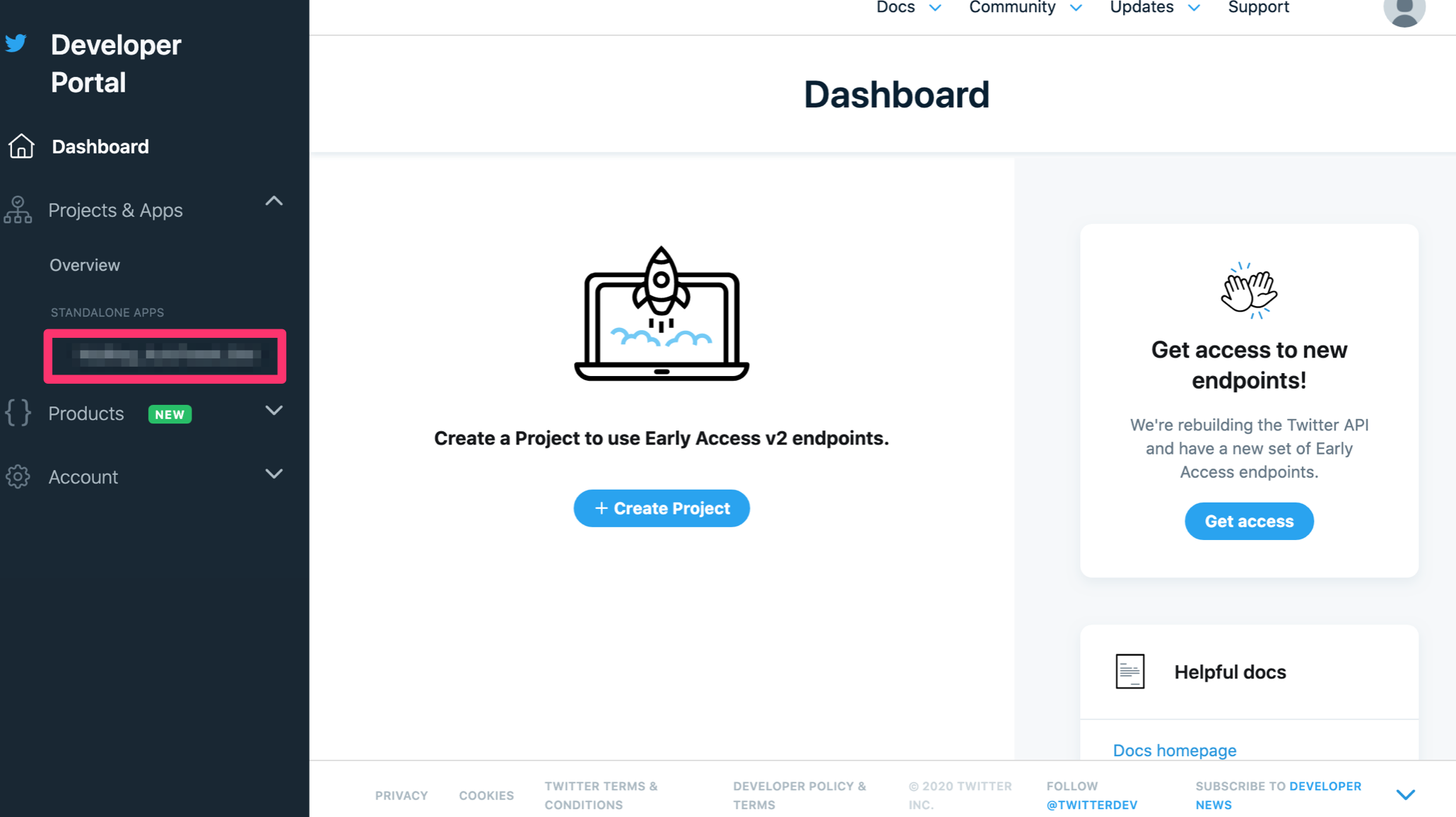

Pythonコードを実行してツイートできるようにする

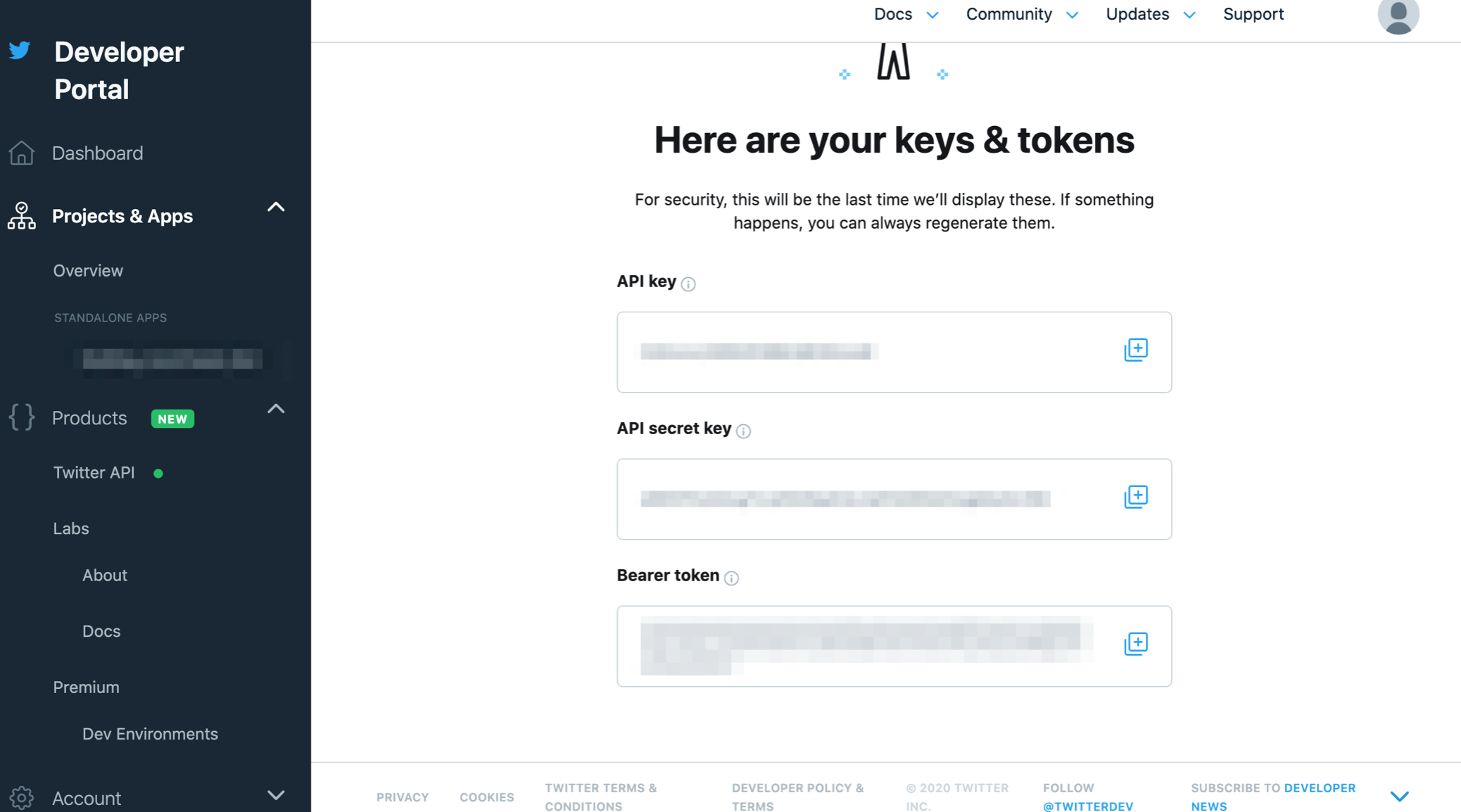

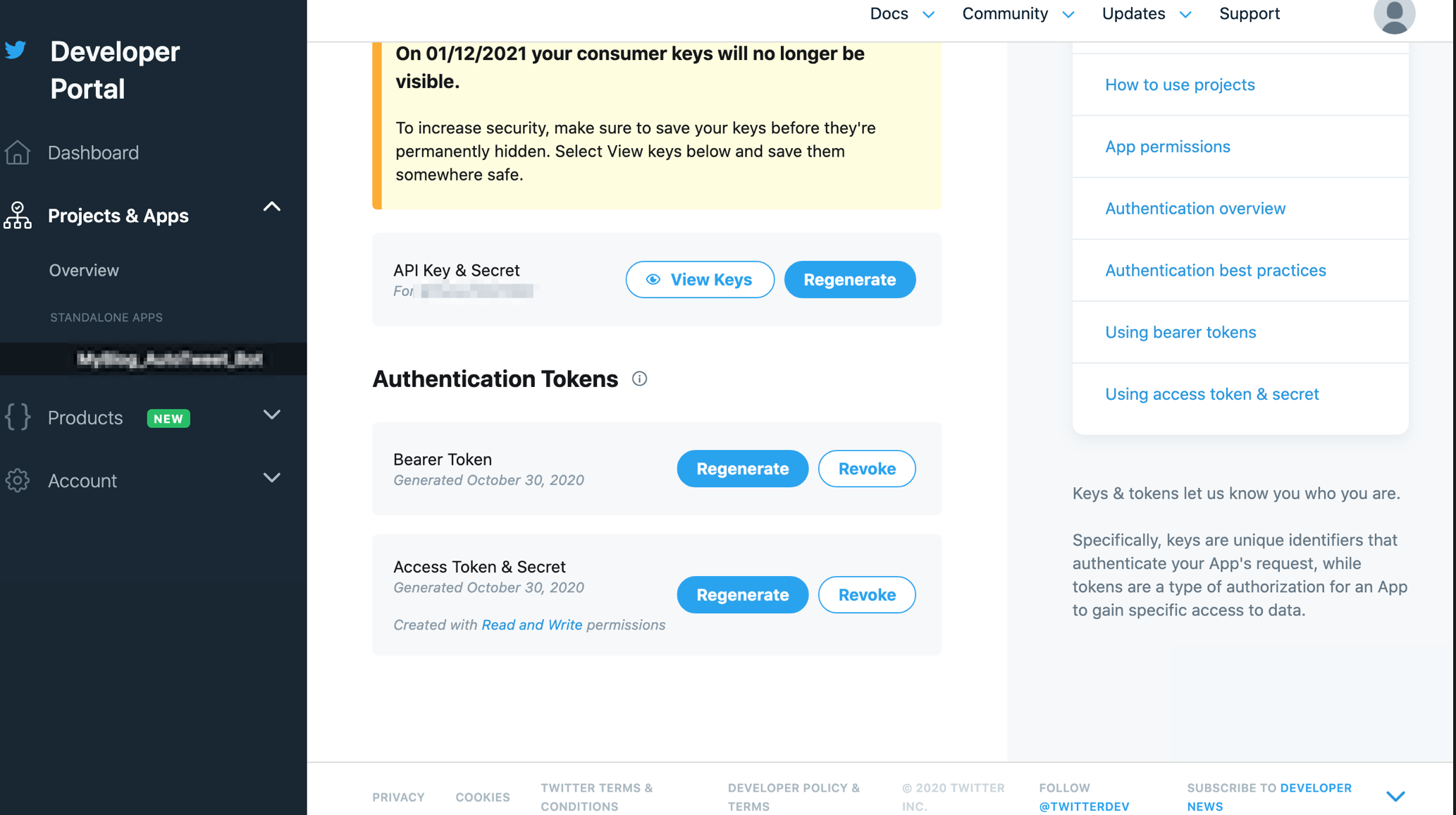

TwitterAPIのAPIキー、トークンを取得

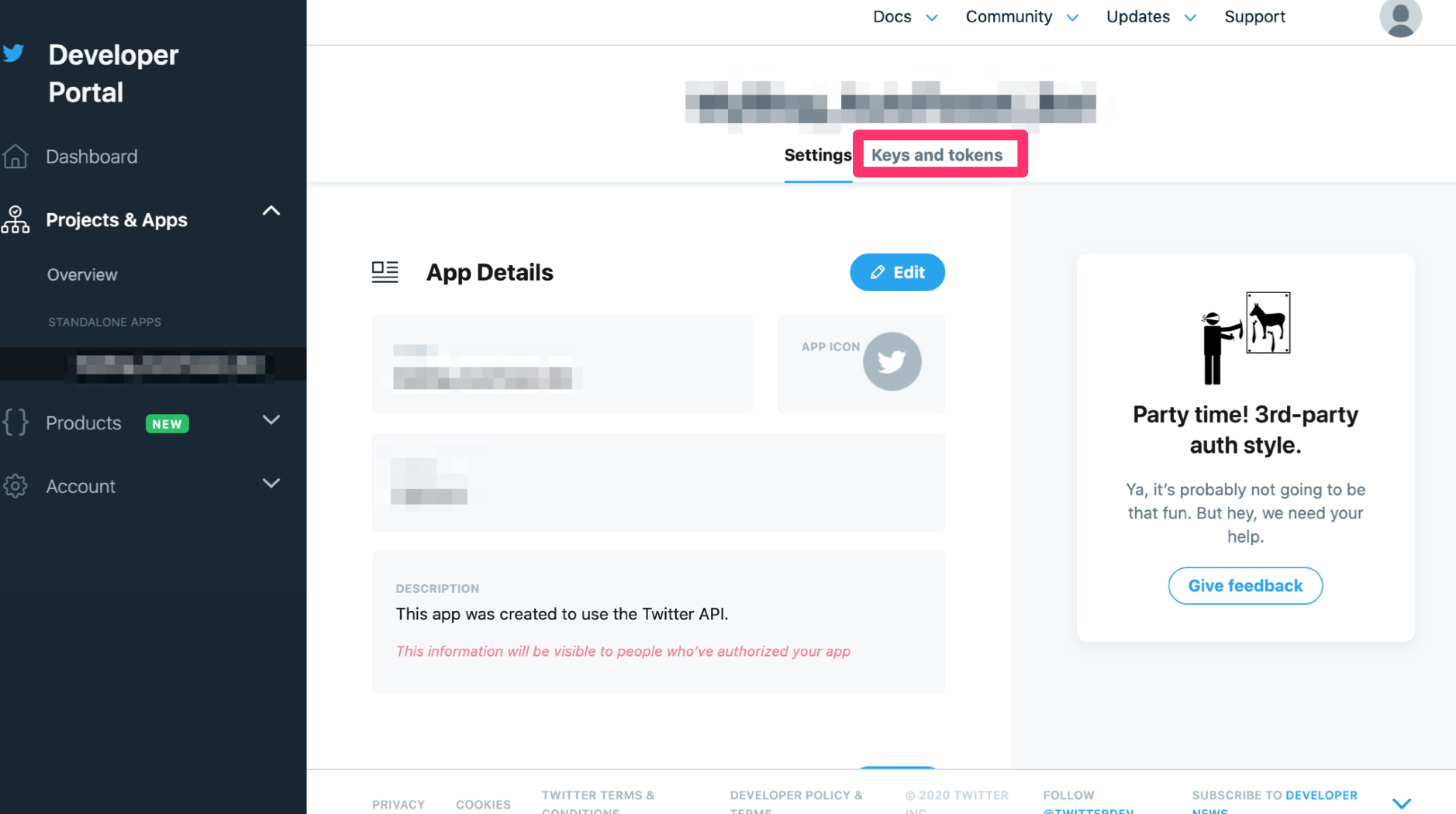

登録したデベロッパーアカウントを使ってAPIキー、トークンを取得します。

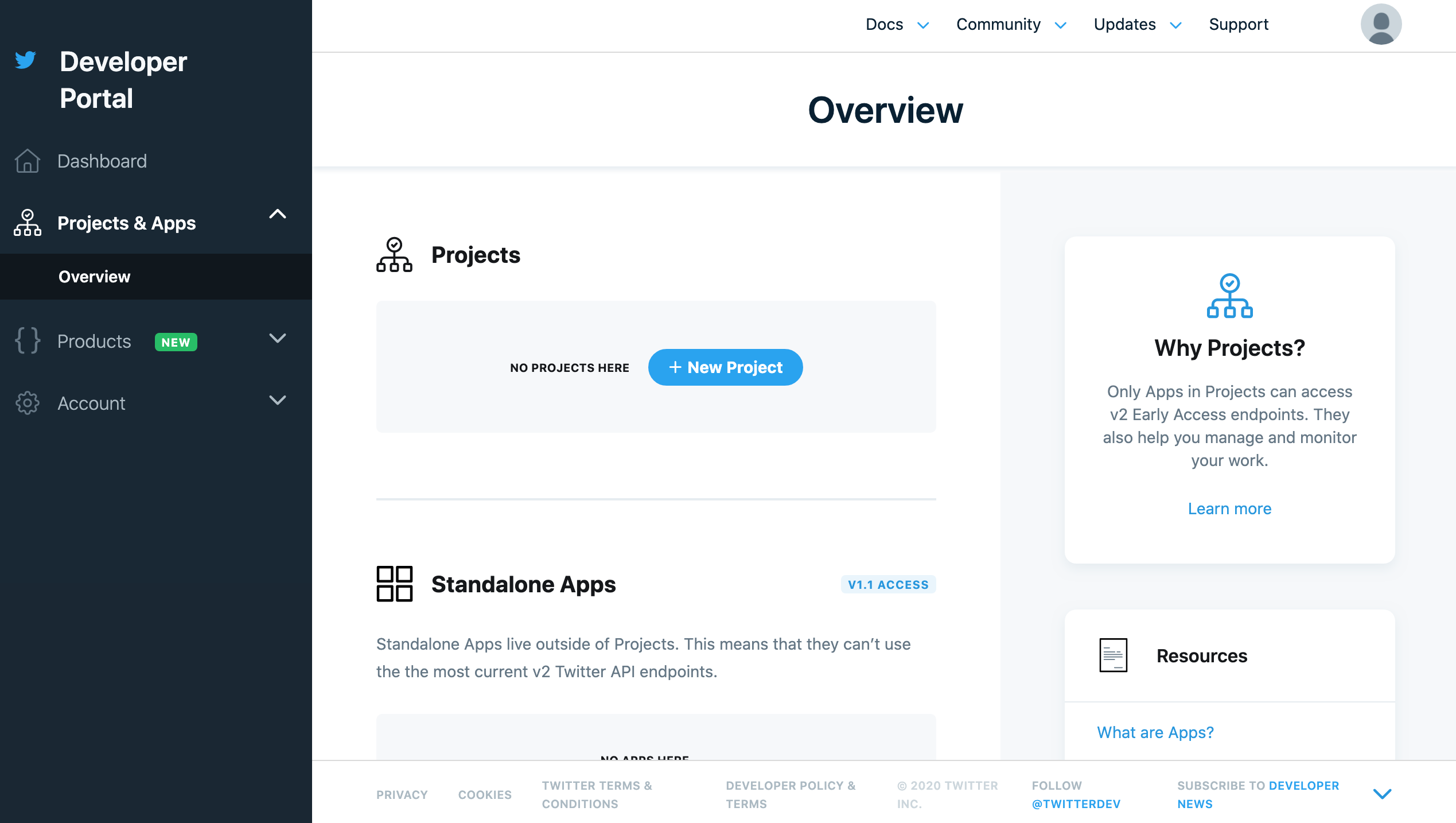

Developerサイトへアクセスすると下のような画面に入れます。

スクロールするとCreate Appがあるのでクリック。

アプリ名を入力。

取得できました。人に見せちゃダメですぞ!!

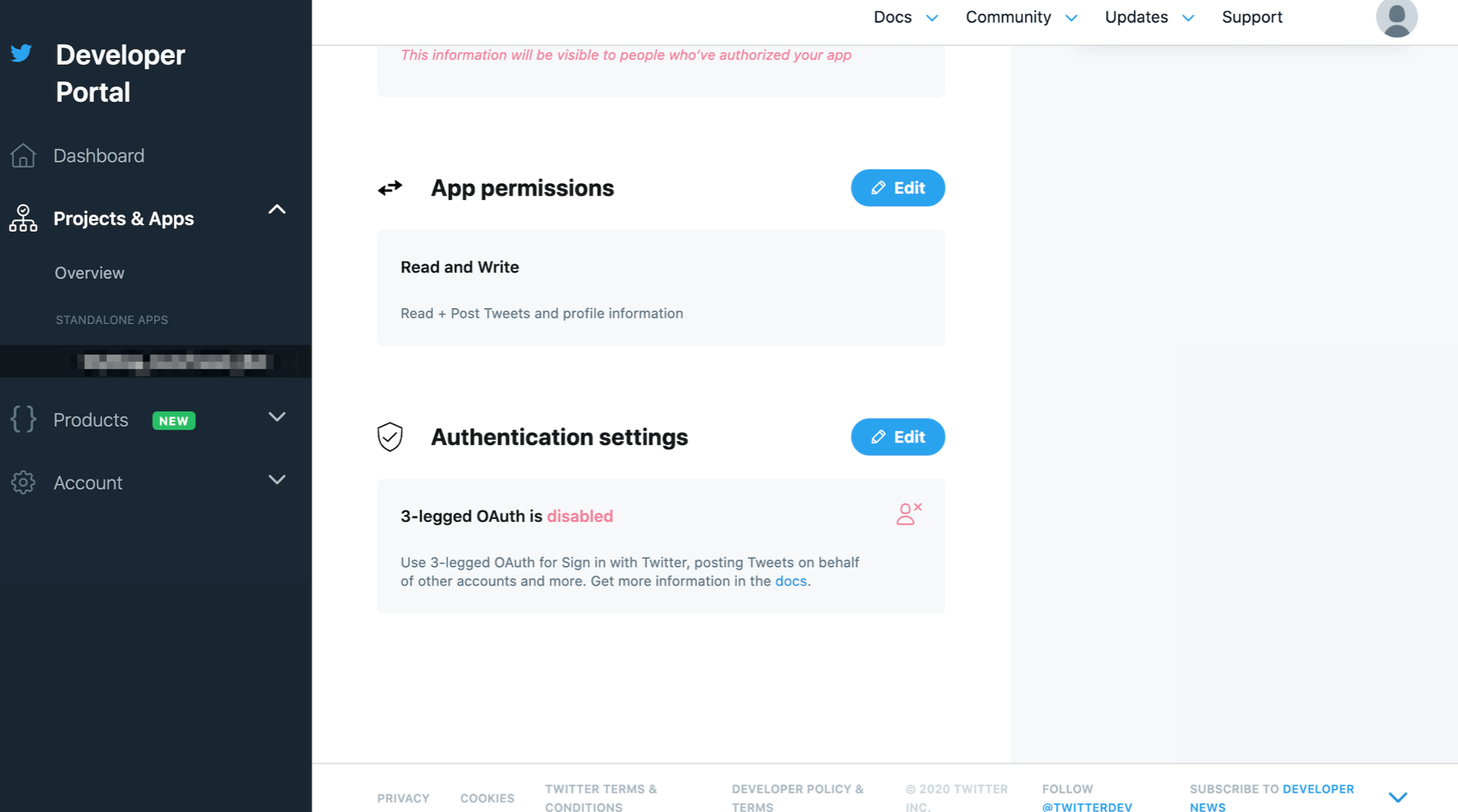

あと今回はツイートをしたいのでAPIの特権の変更が必要です。やっておきましょう。

登録したアプリ名をクリック。

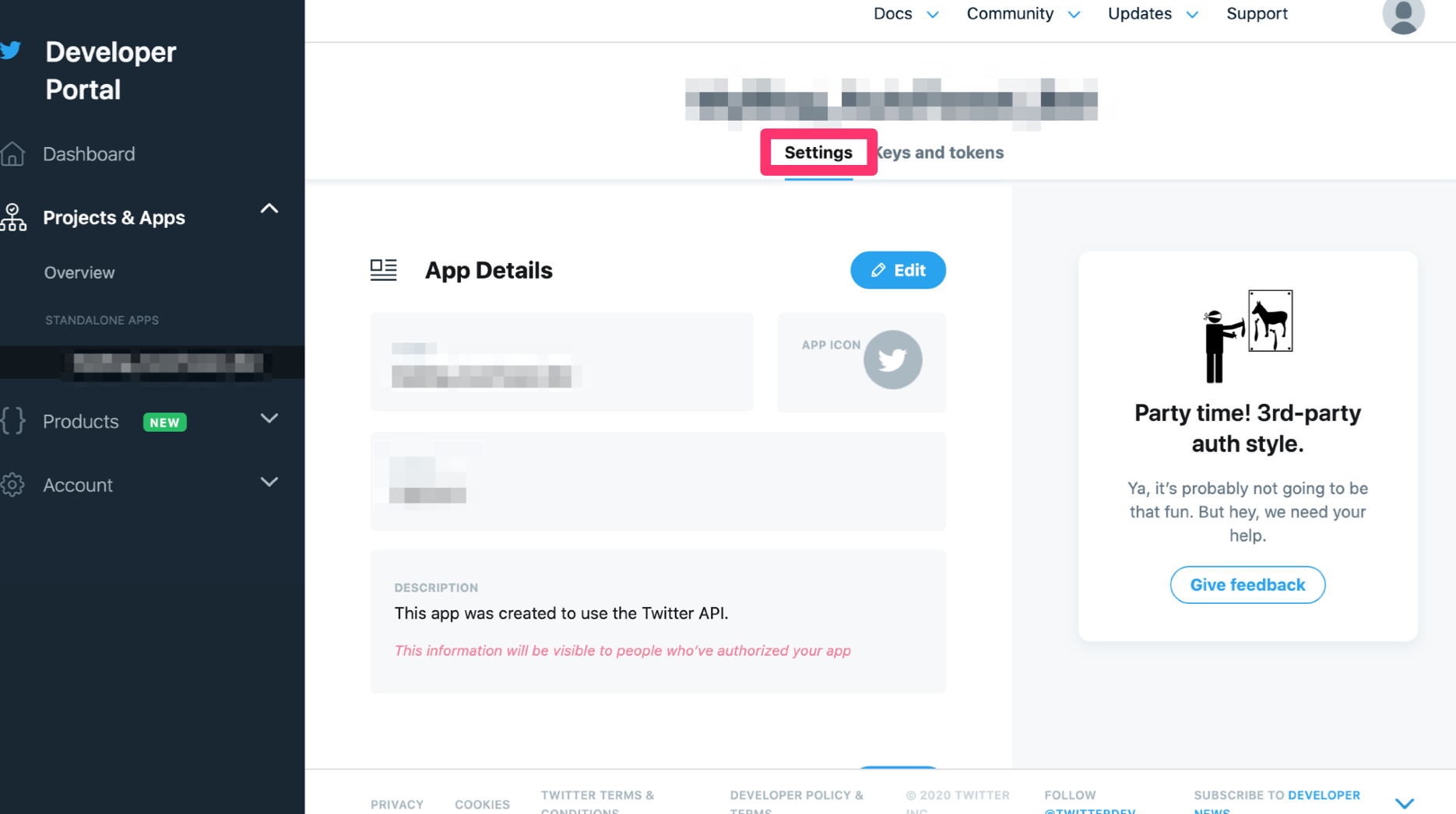

Settingsをクリック。

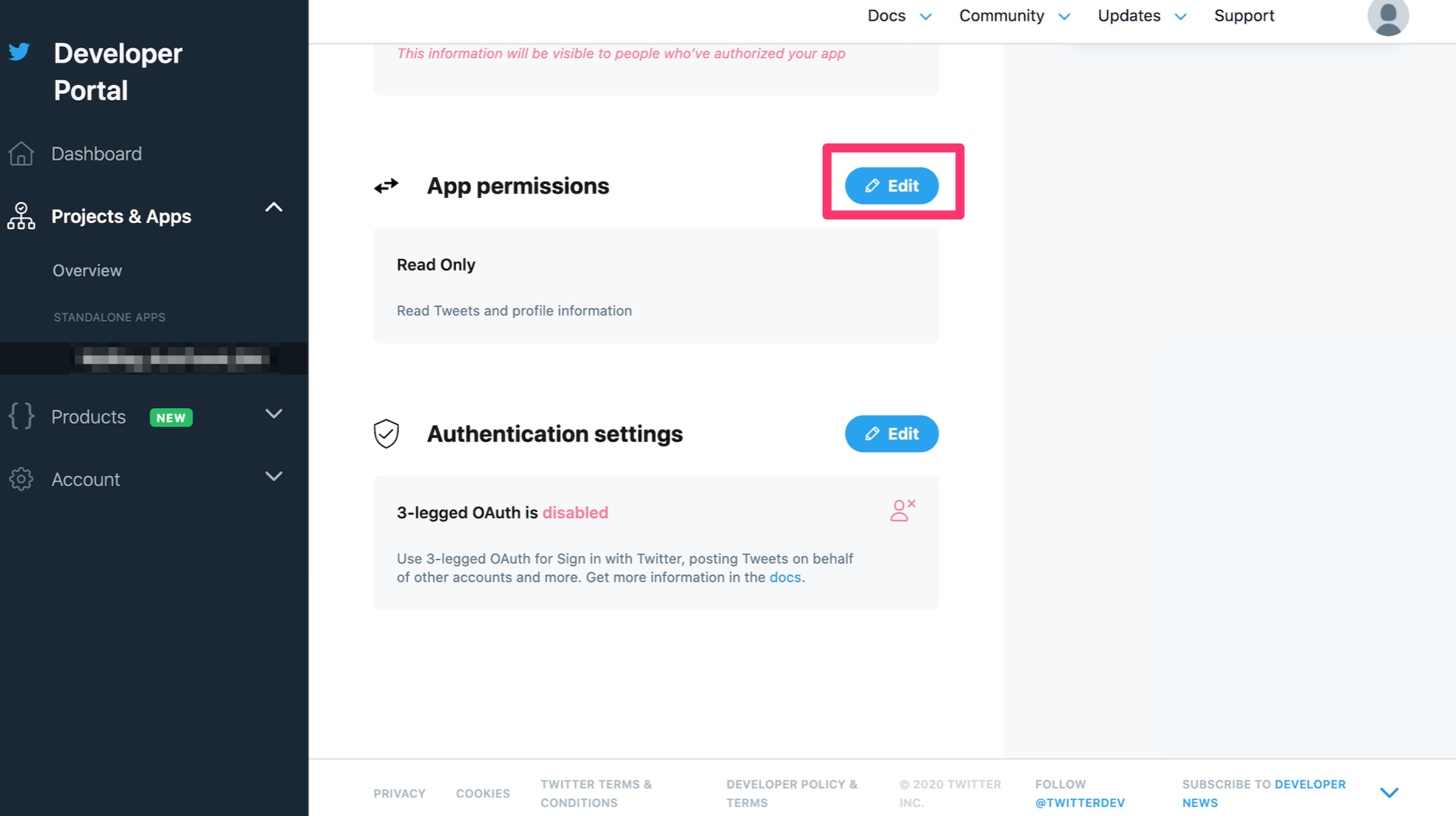

スクロールをして出てくるApp permissionsをRead OnlyからRead and Writeにします。

Editをクリック。

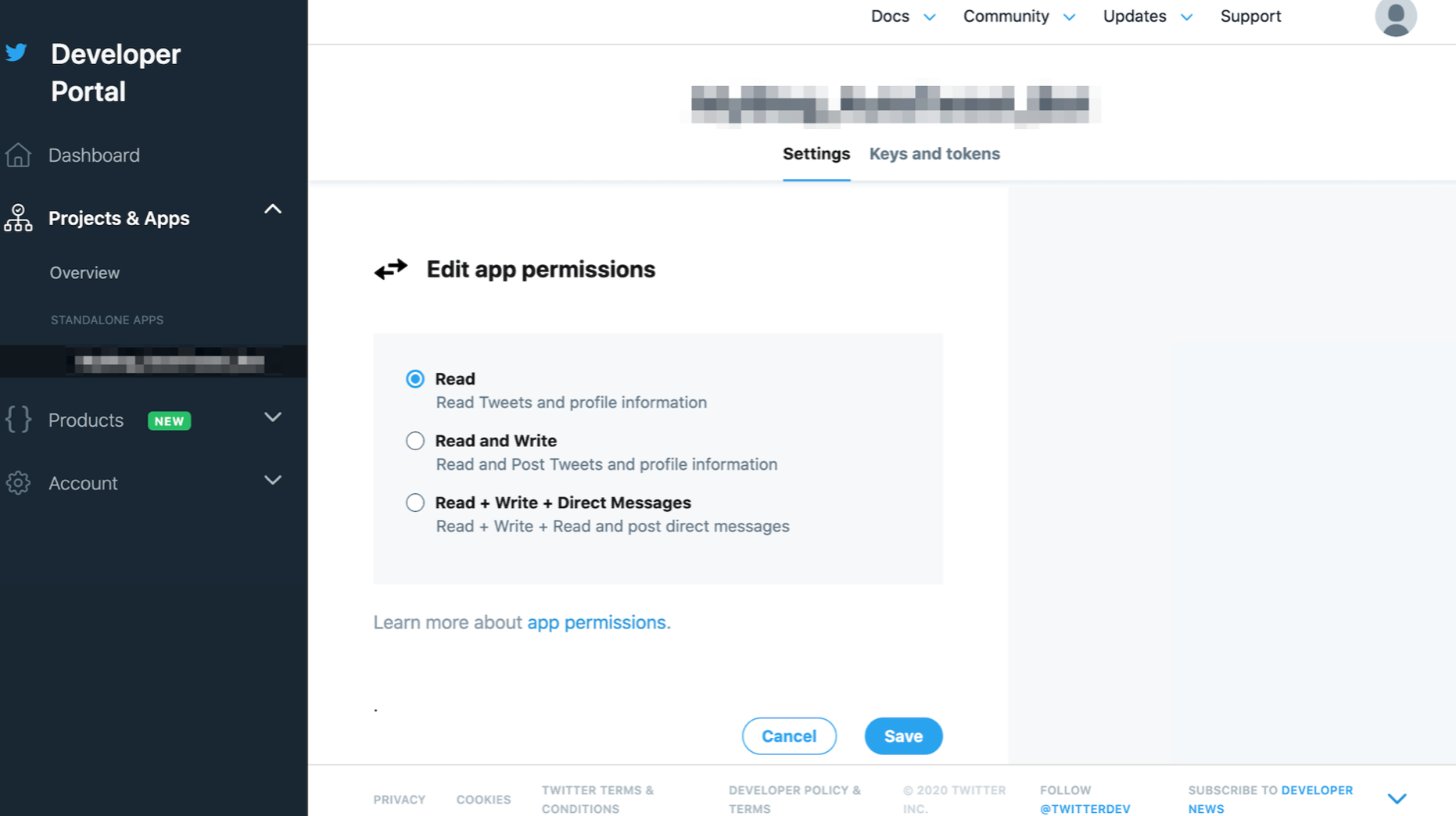

変更できるようになるので、Read and Writeをチェック、Save。

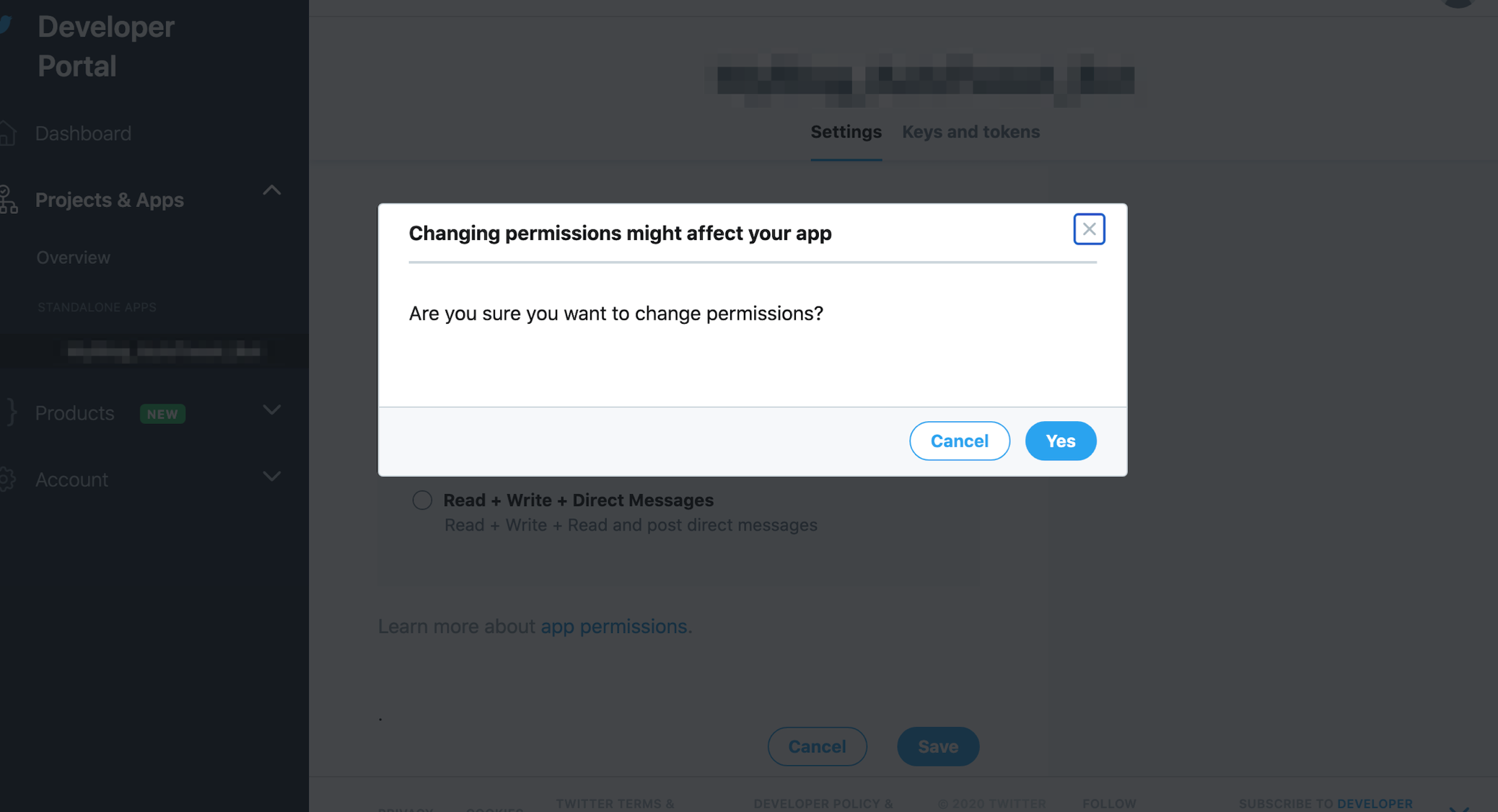

ええんか?と聞かれるのでええんやでとYesをクリック。

TwitterAPIでツイートできる権限を付与できました。

TwitterAPIのAPIキー、トークンを使ってまずはツイートしてみる

TwitterAPIを使うにはリクエスト処理と認証が必要になります。

リクエスト処理はrequestsというライブラリでやるのが一般的です。

また認証はrequests_oauthlibというライブラリがよく使われているみたいですね。ちなみにTwitterは認証方式としてOAuth認証 という認証方法を利用しているので、PythonからTwitterの情報にアクセスする場合はOAuth認証を利用し、TwitterAPIを通して情報のやり取りを行う必要があります。

- OAuth 認証に必要なもの

- Consumer key

- Consumer secret

- Access token

- Access token secret

これらのキーとトークンはさっき作ったやつです!

Developerサイトへアクセス。先ほど登録したアプリ名をクリック。

Keys and tokensをクリック。

ここから取得できます。

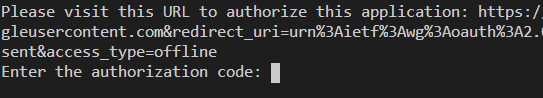

ではではrequestsとrequests_oauthlibをインストールしましょう。

Windowsの方はAnaconda Powershell Promptで、Macの方はターミナルで以下を実行。

ライブラリをインストールしましょう。pip install requests requests_oauthlibあとはコードを実行するだけです。サンプルコードは以下です!取得したAPIキーとトークンを打ち込んで実行してみてください。ツイッターアカウントから「Pythonからのテストツイート」とツイートされているはずです。(感動の涙!!!)

TwitterBot_autoTweet.py

# coding: UTF-8 from requests_oauthlib import OAuth1Session #ここにKeyとToken CONSUMER_KEY = "XXXXXXXXXXXX" CONSUMER_SECRET = "XXXXXXXXXXXXXXXXXXXXXXXXXX" ACCESS_TOKEN = "XXXXXXXXXXXX-XXXXXXXXXXXXXXXX" ACCESS_TOKEN_SECRET = "XXXXXXXXXXXXXXXXXXXXXXXXXX" twitter = OAuth1Session(CONSUMER_KEY, CONSUMER_SECRET, ACCESS_TOKEN, ACCESS_TOKEN_SECRET) url = "https://api.twitter.com/1.1/statuses/update.json" tweet = "Pythonからのテストツイート" #ツイート内容 params = {"status" : tweet} req = twitter.post(url, params = params) #ここでツイート if req.status_code == 200: #成功 print("Succeed!") else: #エラー print("ERROR : %d"% req.status_code)ツイートしたいブログの全記事のURLを一覧化したページを作る

無事にツイートできたので本命のブログ記事を自動ツイートするための下ごしらえです。

ブログの記事一つ一つをスクレイピングしてツイートするコードを書いてもいいのですが、記事が増えるたびに手直しが必要になるので、ツイートしたいブログの全記事を一覧化したページを作り、そこからURLをスクレイピングしてくるといった方法を取ります。

ブログはWordpressで作成している前提で話を進めます。

Wordpressでブログを作っているなら全記事一覧はプラグイン1つで簡単に作成できます。

使うプラグインは「PS Auto Sitemap」です。

Wordpressの管理画面からプラグインページに入り、新規追加で「PS Auto Sitemap」と検索してインストール、有効化します。

次にページを作成します。固定ページで「全記事一覧」という名前にでもして作成すれば良いと思います。(←なんでも大丈夫です)

記事の中にカスタムHTMLコードで以下のコードを書きます。<!-- SITEMAP CONTENT REPLACE POINT -->

コードを書いたら記事を公開、その記事のIDを控えておいておきます。

PS Auto Sitemapの設定画面に入り「サイトマップを表示する記事」にIDを入力します。

これで全記事一覧が作成されるはずです。作成した全記事一覧ページからURLを取得し、ツイートする

作成した全記事一覧ページからURLをスクレイピングして取得します。

スクレイピングにはBeautifulSoupを用います。

ライブラリをインストールしましょう。pip install beautifulsoup4あとはAPIを使った時のようにコードを実行するだけです。サンプルコードは以下です。

これら2つのプログラムを同一フォルダに作成して、TwitterBot.pyに取得したAPIキーとトークンを、getBlogURL.pyに全記事一覧ページのURLを打ち込んで実行してみてください。TwitterBot.py

# coding: UTF-8 from requests_oauthlib import OAuth1Session from getBlogURL import post_article #ここにKeyとToken CONSUMER_KEY = "XXXXXXXXXXXXXXXXXXXX" CONSUMER_SECRET = "XXXXXXXXXXXXXXXXXXX" ACCESS_TOKEN = "XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXX" ACCESS_TOKEN_SECRET = "XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXX" twitter = OAuth1Session(CONSUMER_KEY, CONSUMER_SECRET, ACCESS_TOKEN, ACCESS_TOKEN_SECRET) url = "https://api.twitter.com/1.1/statuses/update.json" tweet = post_article #ツイート内容 params = {"status" : tweet} req = twitter.post(url, params = params) #ここでツイート if req.status_code == 200: #成功 print("Succeed!") else: #エラー print("ERROR : %d"% req.status_code)getBlogURL.py

import requests from bs4 import BeautifulSoup import random # 全記事一覧のURLからツイートしたいURLを引っ張ってくる res = requests.get("全記事一覧のURL") soup = BeautifulSoup(res.text, "html.parser") links = [] for url in soup.find_all('a'): url.get = url.get('href') #URLが取得できない場合はパス if url.get is None: continue #URLに文字"abc"があったらURLをツイートしない if "abc" not in url.get: links.append(url.get) post_article=random.choice(links)ちなみにgetBlogURL.pyの以下の実装部分で"abc"を任意の文字に変更すると入力した文字がURLに含まれないときだけがツイートされるようになります。逆に含まれるものだけツイートしたい場合はnot inをinにすればよいです。

if "abc" not in url.get:いろいろとツイートする記事に条件を付けたい場合は以下のようにgetBlogURL.pyのfor文内を変更すれば良いです。

for url in soup.find_all('a'): url.get = url.get('href') if url.get is None: continue #URLに文字"abc"があったらURLをツイートする if "abc" not in url.get: continue #URLに文字"def"があったらURLをツイートしない if "initial-search" in url.get: continue #URLが"https://abc.com/"だったらURLをツイートしない if url.get == "https://abc.com/": continue #URLに文字"jkl"があったらURLをツイートする if "jkl" in url.get: links.append(url.get)適当なサーバーでcronを用いて定期実行されるようにする

最後です。作成したプログラムを家にある適当なUbuntuサーバー(Macでも可)で定期実行しましょう!

定期実行にはcronでスクリプトを定刻実行するのが楽だと思います。作成したいプログラムをサーバーにコピーする

FTPなりUSBなり何でもよいのでサーバーにコピーしてください。

cronをroot権限で開く。

サーバーのコマンドラインで以下を実行。

crontab -u root -eコマンドを登録

以下のコマンドをcronに登録してください。(必要なツイートの頻度などに変更してね!)

サンプルは4時間おきに「/home/tweet/TwitterBot.py」を実行するといったコマンドになっています。* * /4 * * * python3 /home/tweet/TwitterBot.pyこれで4時間ごとに記事をツイートするBotの完成です。

参考にした、参考になるサイト

- 投稿日:2020-11-08T21:34:51+09:00

[Django] aws cloud9環境でpython manage.py実行したらsqliteのバージョンエラー

今までmac上でdocker環境を立ち上げてDjangoの学習をしていましたが、cloud9で行う記事を見てawsの勉強になるかもしれないと考えcloud9を試してみました。ただコードを書く前のmanage.pyの実行でエラーしてしまい解決するまで時間がかかったのでメモを残します。

環境 : aws cloud9のamazon linux2

/etc/system-release$ cat /etc/system-release Amazon Linux release 2 (Karoo)$ python manage.py startapp blog Traceback (most recent call last): File "manage.py", line 21, in <module> ・・・略・・・ raise ImproperlyConfigured('SQLite 3.8.3 or later is required (found %s).' % Database.sqlite_version) django.core.exceptions.ImproperlyConfigured: SQLite 3.8.3 or later is required (found 3.7.17) $ python -V Python 3.7.9 $ sqlite3 --version 3.33.0 2020-08-14 13:23:32バージョンは問題なさそう。

$ which sqlite3 /home/linuxbrew/.linuxbrew/bin/sqlite3 $ /usr/bin/sqlite3 --version 3.7.17 2013-05-20 00:56:22コマンドラインからはlinuxbrew配下のsqlite3が見えているがpythonからは/usr/bin/sqlite3が見えている?

調べるとsqlite3が古いから最新版をインストールする記事が多かったが、その中で最新版インストール先のlibをLD_LIBRARY_PATHに設定するというの記事があったので真似してみた。export LD_LIBRARY_PATH=/home/linuxbrew/.linuxbrew/lib:${LD_LIBRARY_PATH}無事manage.pyの実行ができました。linuxbrewは知りませんでしたがhomebrewのlinux版

。LD_LIBRARY_PATHも設定しておくと良いと見つけた記事にありましたが、cloud9ではlinuxbrewはインストールされているがLD_LIBRARY_PATHは設定されていないようでした(.bashrcへの記述はなかった)。### LD_LIBLARY_PATHを設定しないといけないのはなんとなくわかるが何で必要かよくわかっていない。

参考

https://qiita.com/rururu_kenken/items/8202b30b50e3bfa75821

https://qiita.com/thermes/items/926b478ff6e3758ecfea

- 投稿日:2020-11-08T21:28:50+09:00

PyCharmでCmderを使う方法(Windows)

ご覧下さりありがとうございます。

掲題の件について、私が取り組んだ際に日本語で得られる情報の乏しさを感じたため、以下記事として記します。手順

- 環境変数の追加

- コントロールパネル→システム→システムの詳細設定→環境変数 と進み、ユーザーの環境変数として「CMDER_ROOT」、値(パス)にはCmder.exeの格納ディレクトリを記入(大抵は「C:\hogehoge\cmder」のはず)

- PyCharmの設定を変更

- PyCharmのSettings→Terminalに進み、Shell Path欄に「"cmd.exe" /k ""%CMDER_ROOT%\vendor\init.bat""」と入力する(ダブルクオーテーション二重は誤植ではありません)

- PyCharm再起動→Alt + F12でCmderが起動する(≒Linux系のコマンド[lsなど]が通る)ことを確認

参考

- https://stackoverflow.com/questions/8713960/cmd-exe-k-switch

- https://github.com/cmderdev/cmder/issues/282

(以上)

- 投稿日:2020-11-08T21:28:37+09:00

Dockerのベースイメージの記述方法

ベストプラクティスを読んでみた

可能であれば、自分のイメージの元として現在の公式レポジトリを使います。私たちは Debian イメージ を推奨します。これは、非常にしっかりと管理されており、ディストリビューションの中でも最小(現在は 100 MB 以下)になるよう維持されているからです。

というわけでDebian系を使うようにしましょう。

どうやって選ぶの?

- ベースのOSを決める。ubuntuとかcentosとかpythonとか。

- docker searchコマンドで公式を選ぶ。無難にSTARSが一番多いやつでいいでしょう。

- Dockerhubで公式のイメージを検索するとTags一覧があるのでそこから選ぶ。

- FROM {イメージ名}:{タグ名}

例

FROM python:rc-alpine3.12

- 投稿日:2020-11-08T20:58:28+09:00

TMDbのAPIの映画情報をPythonで取得してみた

TMDb、TMDbのAPIについて

TMDb1 (The Movie Database)は映画やテレビ番組のデータをコミュニティベースで集めているデータベースだそうです。このサービスにはAPIがあり2、様々な情報をプログラムを介して取得することができます。APIの利用のためには、アカウントの登録後、利用申請が必要です。(ちなみに、このAPIは現時点でAPI rate limitingが無いようです!3)

Pythonで実装

- python 3.6.5

APIを叩くPythonのクラスを定義します。今回はmovieの情報に絞って試してみます。tokenはAPI利用申請後に生成される、APIリードアクセストークンと呼ばれるものを使用します。

import requests import json from pprint import pprint class TMDB: def __init__(self, token): self.token = token self.headers_ = {'Authorization': f'Bearer {self.token}', 'Content-Type': 'application/json;charset=utf-8'} self.base_url_ = 'https://api.themoviedb.org/3/' self.img_base_url_ = 'https://image.tmdb.org/t/p/w500' def _json_by_get_request(self, url, params={}): res = requests.get(url, headers=self.headers_, params=params) return json.loads(res.text) def search_movies(self, query): params = {'query': query} url = f'{self.base_url_}search/movie' return self._json_by_get_request(url, params) def get_movie(self, movie_id): url = f'{self.base_url_}movie/{movie_id}' return self._json_by_get_request(url) def get_movie_account_states(self, movie_id): url = f'{self.base_url_}movie/{movie_id}/account_states' return self._json_by_get_request(url) def get_movie_alternative_titles(self, movie_id, country=None): url = f'{self.base_url_}movie/{movie_id}/alternative_titles' return self._json_by_get_request(url) def get_movie_changes(self, movie_id, start_date=None, end_date=None): url = f'{self.base_url_}movie/{movie_id}' return self._json_by_get_request(url) def get_movie_credits(self, movie_id): url = f'{self.base_url_}movie/{movie_id}/credits' return self._json_by_get_request(url) def get_movie_external_ids(self, movie_id): url = f'{self.base_url_}movie/{movie_id}/external_ids' return self._json_by_get_request(url) def get_movie_images(self, movie_id, language=None): url = f'{self.base_url_}movie/{movie_id}/images' return self._json_by_get_request(url) def get_movie_keywords(self, movie_id): url = f'{self.base_url_}movie/{movie_id}/keywords' return self._json_by_get_request(url) def get_movie_release_dates(self, movie_id): url = f'{self.base_url_}movie/{movie_id}/release_dates' return self._json_by_get_request(url) def get_movie_videos(self, movie_id, language=None): url = f'{self.base_url_}movie/{movie_id}/videos' return self._json_by_get_request(url) def get_movie_translations(self, movie_id): url = f'{self.base_url_}movie/{movie_id}/translations' return self._json_by_get_request(url) def get_movie_recommendations(self, movie_id, language=None): url = f'{self.base_url_}movie/{movie_id}/recommendations' return self._json_by_get_request(url) def get_similar_movies(self, movie_id, language=None): url = f'{self.base_url_}movie/{movie_id}/similar' return self._json_by_get_request(url) def get_movie_reviews(self, movie_id, language=None): url = f'{self.base_url_}movie/{movie_id}/reviews' return self._json_by_get_request(url) def get_movie_lists(self, movie_id, language=None): url = f'{self.base_url_}movie/{movie_id}/lists' return self._json_by_get_request(url) def get_latest_movies(self, language=None): url = f'{self.base_url_}movie/latest' return self._json_by_get_request(url) def get_now_playing_movies(self, language=None, region=None): url = f'{self.base_url_}movie/now_playing' return self._json_by_get_request(url) def get_popular_movies(self, language=None, region=None): url = f'{self.base_url_}movie/popular' return self._json_by_get_request(url) def get_top_rated_movies(self, language=None, region=None): url = f'{self.base_url_}movie/top_rated' return self._json_by_get_request(url) def get_upcoming_movies(self, language=None, region=None): url = f'{self.base_url_}movie/upcoming' return self._json_by_get_request(url)以下の実行結果はすべて次のリンクのノートブックで確認できます

https://colab.research.google.com/drive/11jK7yuluSdA-YBAsrm7wmHJpEwJSyE7L?authuser=0

映画の検索

インスタンスを作成して、まずは映画を検索してこのAPIにおける映画のIDを取得します

api = TMDB(token) # tokenは発行された文字列を代入 res = api.search_movies("万引き家族") pprint(res){'page': 1, 'results': [{'adult': False, 'backdrop_path': '/xOpQ4jIQJ0HSUhVDixZA9yWqVBP.jpg', 'genre_ids': [18, 80], 'id': 505192, 'original_language': 'ja', 'original_title': '万引き家族', 'overview': 'After one of their shoplifting sessions, Osamu and ' 'his son come across a little girl in the freezing ' 'cold. At first reluctant to shelter the girl, ' 'Osamu’s wife agrees to take care of her after ' 'learning of the hardships she faces. Although the ' 'family is poor, barely making enough money to ' 'survive through petty crime, they seem to live ' 'happily together until an unforeseen incident ' 'reveals hidden secrets, testing the bonds that ' 'unite them.', 'popularity': 16.385, 'poster_path': '/4nfRUOv3LX5zLn98WS1WqVBk9E9.jpg', 'release_date': '2018-06-02', 'title': 'Shoplifters', 'video': False, 'vote_average': 7.9, 'vote_count': 1128}], 'total_pages': 1, 'total_results': 1}詳細情報

今回は検索結果が1件だったので、最初のインデックスを指定して映画のIDを保持しておきます。このIDを指定して詳細情報を取得できます

movie_id = res['results'][0]['id'] api.get_movie(movie_id) #=> {'adult': False, 'backdrop_path': '/xOpQ4jIQJ0HSUhVDixZA9yWqVBP.jpg', 'belongs_to_collection': None, 'budget': 0, 'genres': [{'id': 18, 'name': 'Drama'}, {'id': 80, 'name': 'Crime'}], 'homepage': 'https://www.shopliftersfilm.com', 'id': 505192, 'imdb_id': 'tt8075192', 'original_language': 'ja', 'original_title': '万引き家族', 'overview': 'After one of their shoplifting sessions, Osamu and his son come across a little girl in the freezing cold. At first reluctant to shelter the girl, Osamu’s wife agrees to take care of her after learning of the hardships she faces. Although the family is poor, barely making enough money to survive through petty crime, they seem to live happily together until an unforeseen incident reveals hidden secrets, testing the bonds that unite them.', 'popularity': 16.385, 'poster_path': '/4nfRUOv3LX5zLn98WS1WqVBk9E9.jpg', 'production_companies': [{'id': 84048, 'logo_path': '/nu8Q8IvG2fazeI7axTnUhAvzrqy.png', 'name': 'Gaga Corporation', 'origin_country': 'JP'}, {'id': 3341, 'logo_path': '/dTG5dXE1kU2mpmL9BNnraffckLU.png', 'name': 'Fuji Television Network', 'origin_country': 'JP'}, {'id': 39804, 'logo_path': None, 'name': 'AOI Promotion', 'origin_country': 'JP'}, {'id': 75214, 'logo_path': None, 'name': 'Bunbuku', 'origin_country': 'JP'}], 'production_countries': [{'iso_3166_1': 'JP', 'name': 'Japan'}], 'release_date': '2018-06-02', 'revenue': 0, 'runtime': 121, 'spoken_languages': [{'iso_639_1': 'ja', 'name': '日本語'}], 'status': 'Released', 'tagline': '', 'title': 'Shoplifters', 'video': False, 'vote_average': 7.9, 'vote_count': 1128}ポスターなどの画像

画像はbackdropsとpostersの2つに別れており、backdropsは映画中のワンショット、postersは上映国におけるポスターの画像の情報が取得できます。試しにbackdropsのみ置いておきます。

また以下のリンクですべての画像を確認できます。結構な数があるので見ていて楽しいです(というか日本バージョンには無いポスターが結構ある...)

res = api.get_movie_images(movie_id) for backdrop in res['backdrops']: print(f"<img src={api.img_base_url_}{backdrop['file_path']}>") #=>国によるタイトルの違い

国によっていろんなタイトルの付け方がされている場合は、国ごとのタイトルを取得できます。この辺は他のデータやサービスでは得づらい情報な気がします

pprint(api.get_movie_alternative_titles(movie_id)) #=> {'id': 505192, 'titles': [{'iso_3166_1': 'JP', 'title': 'Manbiki Kazoku', 'type': 'romaji'}, {'iso_3166_1': 'US', 'title': 'Shoplifting Family', 'type': 'literal translation'}, {'iso_3166_1': 'KR', 'title': '어느 가족', 'type': ''}, {'iso_3166_1': 'UA', 'title': 'Магазинні злодюжки', 'type': ''}, {'iso_3166_1': 'GB', 'title': 'Shoplifters', 'type': ''}, {'iso_3166_1': 'JP', 'title': 'Manbiki kazoku (Shoplifters)', 'type': ''}, {'iso_3166_1': 'AR', 'title': 'Somos una familia', 'type': ''}, {'iso_3166_1': 'CN', 'title': '小偷家族', 'type': ''}, {'iso_3166_1': 'BR', 'title': 'Assunto de Família', 'type': ''}]}売上?、収入?

返ってくる値にbudgetとかrevenueとかがあるので、お金の話みたいですが、今回は特に情報がなく良く分かってないです

pprint(api.get_movie_changes(movie_id, start_date="2018/06/08", end_date="2018/06/15")) #=> {'adult': False, 'backdrop_path': '/xOpQ4jIQJ0HSUhVDixZA9yWqVBP.jpg', 'belongs_to_collection': None, 'budget': 0, 'genres': [{'id': 18, 'name': 'Drama'}, {'id': 80, 'name': 'Crime'}], 'homepage': 'https://www.shopliftersfilm.com', 'id': 505192, 'imdb_id': 'tt8075192', 'original_language': 'ja', 'original_title': '万引き家族', 'overview': 'After one of their shoplifting sessions, Osamu and his son come ' 'across a little girl in the freezing cold. At first reluctant to ' 'shelter the girl, Osamu’s wife agrees to take care of her after ' 'learning of the hardships she faces. Although the family is ' 'poor, barely making enough money to survive through petty crime, ' 'they seem to live happily together until an unforeseen incident ' 'reveals hidden secrets, testing the bonds that unite them.', 'popularity': 16.385, 'poster_path': '/4nfRUOv3LX5zLn98WS1WqVBk9E9.jpg', 'production_companies': [{'id': 84048, 'logo_path': '/nu8Q8IvG2fazeI7axTnUhAvzrqy.png', 'name': 'Gaga Corporation', 'origin_country': 'JP'}, {'id': 3341, 'logo_path': '/dTG5dXE1kU2mpmL9BNnraffckLU.png', 'name': 'Fuji Television Network', 'origin_country': 'JP'}, {'id': 39804, 'logo_path': None, 'name': 'AOI Promotion', 'origin_country': 'JP'}, {'id': 75214, 'logo_path': None, 'name': 'Bunbuku', 'origin_country': 'JP'}], 'production_countries': [{'iso_3166_1': 'JP', 'name': 'Japan'}], 'release_date': '2018-06-02', 'revenue': 0, 'runtime': 121, 'spoken_languages': [{'iso_639_1': 'ja', 'name': '日本語'}], 'status': 'Released', 'tagline': '', 'title': 'Shoplifters', 'video': False, 'vote_average': 7.9, 'vote_count': 1128}キャスト、スタッフ情報

出演したキャストやスタッフの情報が取得できるようです。これらのデータもcredit_idが振られているようなので、ここからさらにその人の情報が取れるようです。画像もあるみたいです

pprint(api.get_movie_credits(movie_id)) #=> {'cast': [{'cast_id': 0, 'character': 'Osamu Shibata', 'credit_id': '5a845387c3a3682dbf012ac5', 'gender': 2, 'id': 123739, 'name': 'Lily Franky', 'order': 0, 'profile_path': '/8T3I7KQX0SH6twXsuqe12Sc7Hxr.jpg'}, {'cast_id': 1, 'character': 'Nobuyo Shibata', 'credit_id': '5a845394c3a36862e100c84a', 'gender': 1, 'id': 100766, 'name': 'Sakura Ando', 'order': 1, 'profile_path': '/lR1YVfjMYKCMOHzvY3pHTFM5zSI.jpg'}, ...キーワード

TMDb上のキーワードです

pprint(api.get_movie_keywords(movie_id)) #=> {'id': 505192, 'keywords': [{'id': 1328, 'name': 'secret'}, {'id': 10235, 'name': 'family relationships'}, {'id': 12279, 'name': 'family drama'}, {'id': 12369, 'name': 'tokyo, japan'}, {'id': 12987, 'name': 'poverty'}, {'id': 13014, 'name': 'orphan'}, {'id': 155419, 'name': 'shoplifting'}, {'id': 190823, 'name': 'social realism'}, {'id': 209085, 'name': 'shoplifter'}, {'id': 232817, 'name': 'petty crimes'}, {'id': 241445, 'name': 'asian origins'}]}公開日

上映国における公開日の一覧

pprint(api.get_movie_release_dates(movie_id)) #=> {'id': 505192, 'results': [{'iso_3166_1': 'TR', 'release_dates': [{'certification': '', 'iso_639_1': '', 'note': 'Filmekimi', 'release_date': '2018-10-06T00:00:00.000Z', 'type': 1}, {'certification': '', 'iso_639_1': '', 'note': '', 'release_date': '2019-01-18T00:00:00.000Z', 'type': 3}]}, {'iso_3166_1': 'HU', 'release_dates': [{'certification': '', 'iso_639_1': '', 'note': '', 'release_date': '2019-01-10T00:00:00.000Z', 'type': 3}]}, ...Youtube, Vimeoにおける予告編動画

pprint(api.get_movie_videos(movie_id)) #=> {'id': 505192, 'results': [{'id': '5bd4ea970e0a2622dd022b3b', 'iso_3166_1': 'US', 'iso_639_1': 'en', 'key': '9382rwoMiRc', 'name': 'Shoplifters - Official Trailer', 'site': 'YouTube', 'size': 1080, 'type': 'Trailer'}]}このkeyを使ってYoutubeの動画を表示できます

翻訳

タイトルだけでなく概要の文の翻訳文が得られます。これも上映国のみのものと思われます

pprint(api.get_movie_translations(movie_id)) #=> {'id': 505192, 'translations': [{'data': {'homepage': '', 'overview': 'Едно семейство живее на ръба на ' 'бедността като джебчии на дребно. ' 'След един „набег” из магазините, ' 'Осаму и синът му откриват едно малко ' 'момиченце, изоставено в студа. ' 'Съпругата на Осаму решава да помогне ' 'на детето, след като научава през ' 'какви перипетии е преминало. Всички у ' 'дома са задружни и щастливи, въпреки ' 'обстоятелствата, които са ги ' 'принудили да връзват двата края с ' 'помощта на малки кражби всеки ден, но ' 'непредвиден инцидент разкрива тайни, ' 'които поставят на изпитание връзките ' 'между членовете на семейството.', 'runtime': 121, 'tagline': '', 'title': 'Джебчии'}, 'english_name': 'Bulgarian', 'iso_3166_1': 'BG', 'iso_639_1': 'bg', 'name': 'български език'}, ...レコメンデーション

TMDbによるこの映画に対するレコメンデーションを返してくれます。アルゴリズムは不明です

1つ目のレコメンドは村上春樹原作の韓国リメイクでした

pprint(api.get_movie_recommendations(movie_id)) #=> {'page': 1, 'results': [{'adult': False, 'backdrop_path': '/v6eOq707lwWFIG96Rv9sSR6lnnT.jpg', 'genre_ids': [9648, 18, 53], 'id': 491584, 'original_language': 'ko', 'original_title': '버닝', 'overview': 'Deliveryman Jongsu is out on a job when he runs ' 'into Haemi, a girl who once lived in his ' "neighborhood. She asks if he'd mind looking after " "her cat while she's away on a trip to Africa. On " 'her return she introduces to Jongsu an enigmatic ' 'young man named Ben, who she met during her trip. ' 'And one day Ben tells Jongsu about his most unusual ' 'hobby...', 'popularity': 19.981, 'poster_path': '/8ak33l6lfvBPmWOMH9sUCOaC6lq.jpg', 'release_date': '2018-05-17', 'title': 'Burning', 'video': False, 'vote_average': 7.4, 'vote_count': 801}, ...類似する作品

レコメンデーションとは異なり、keywordsやgenreの情報を用いて類似度を計算しているらしいです

pprint(api.get_similar_movies(movie_id)) #=> {'page': 1, 'results': [{'adult': False, 'backdrop_path': '/gSIfujGhazIvswp4R9G6tslAqW7.jpg', 'genre_ids': [18, 10751, 14], 'id': 11236, 'original_language': 'en', 'original_title': 'The Secret Garden', 'overview': 'A young British girl born and reared in India loses ' 'her neglectful parents in an earthquake. She is ' "returned to England to live at her uncle's castle. " 'Her uncle is very distant due to the loss of his ' 'wife ten years before. Neglected once again, she ' 'begins exploring the estate and discovers a garden ' 'that has been locked and neglected. Aided by one of ' "the servants' boys, she begins restoring the " 'garden, and eventually discovers some other secrets ' 'of the manor.', 'popularity': 11.531, 'poster_path': '/2B8yOYHrp0AopX3gk4b7jWH3Q5a.jpg', 'release_date': '1993-08-13', 'title': 'The Secret Garden', 'video': False, 'vote_average': 7.3, 'vote_count': 571}, ...レビュー

ユーザーによるレビューが取れるらしいです。今回は何もなかったですが(焦)

pprint(api.get_movie_reviews(movie_id)) #=> {'id': 505192, 'page': 1, 'results': [], 'total_pages': 0, 'total_results': 0}この映画が含まれているリスト

この映画が属しているリストが返ってくるとドキュメントにはありました。(TMDbにおけるリストとは...)

pprint(api.get_movie_lists(movie_id)) #=> {'id': 505192, 'page': 1, 'results': [{'description': '', 'favorite_count': 0, 'id': 107706, 'iso_639_1': 'en', 'item_count': 4434, 'list_type': 'movie', 'name': 'Watched Movies', 'poster_path': None}, {'description': 'Vari', 'favorite_count': 0, 'id': 137511, 'iso_639_1': 'en', 'item_count': 89, 'list_type': 'movie', 'name': 'Film esteri', 'poster_path': None}, {'description': '', 'favorite_count': 0, 'id': 130541, 'iso_639_1': 'it', 'item_count': 196, 'list_type': 'movie', 'name': '2020', 'poster_path': None}, ...最新の作品

これ以降は検索した映画ではなく、作品全体から抽出する形式です

pprint(api.get_latest_movies()) #=> {'adult': False, 'backdrop_path': None, 'belongs_to_collection': None, 'budget': 0, 'genres': [], 'homepage': '', 'id': 761504, 'imdb_id': None, 'original_language': 'fr', 'original_title': 'Otto Skorzeny, chef de commando nazi et agent du Mossad', 'overview': '', 'popularity': 0.0, 'poster_path': None, 'production_companies': [], 'production_countries': [], 'release_date': '', 'revenue': 0, 'runtime': 0, 'spoken_languages': [{'iso_639_1': 'fr', 'name': 'Français'}], 'status': 'Released', 'tagline': '', 'title': 'Otto Skorzeny, chef de commando nazi et agent du Mossad', 'video': False, 'vote_average': 8.0, 'vote_count': 1}公開中の作品

pprint(api.get_now_playing_movies()) #=> {'dates': {'maximum': '2020-11-12', 'minimum': '2020-09-25'}, 'page': 1, 'results': [{'adult': False, 'backdrop_path': '/86L8wqGMDbwURPni2t7FQ0nDjsH.jpg', 'genre_ids': [28, 53], 'id': 724989, 'original_language': 'en', 'original_title': 'Hard Kill', 'overview': 'The work of billionaire tech CEO Donovan Chalmers ' 'is so valuable that he hires mercenaries to protect ' 'it, and a terrorist group kidnaps his daughter just ' 'to get it.', 'popularity': 2025.862, 'poster_path': '/ugZW8ocsrfgI95pnQ7wrmKDxIe.jpg', 'release_date': '2020-10-23', 'title': 'Hard Kill', 'video': False, 'vote_average': 4.8, 'vote_count': 86}, ...人気の作品

pprint(api.get_popular_movies()) #=> {'page': 1, 'results': [{'adult': False, 'backdrop_path': '/86L8wqGMDbwURPni2t7FQ0nDjsH.jpg', 'genre_ids': [28, 53], 'id': 724989, 'original_language': 'en', 'original_title': 'Hard Kill', 'overview': 'The work of billionaire tech CEO Donovan Chalmers ' 'is so valuable that he hires mercenaries to protect ' 'it, and a terrorist group kidnaps his daughter just ' 'to get it.', 'popularity': 2025.862, 'poster_path': '/ugZW8ocsrfgI95pnQ7wrmKDxIe.jpg', 'release_date': '2020-10-23', 'title': 'Hard Kill', 'video': False, 'vote_average': 4.8, 'vote_count': 86}, ...レートの高い作品

pprint(api.get_top_rated_movies()) #=> {'page': 1, 'results': [{'adult': False, 'backdrop_path': '/jtAI6OJIWLWiRItNSZoWjrsUtmi.jpg', 'genre_ids': [10749], 'id': 724089, 'original_language': 'en', 'original_title': "Gabriel's Inferno Part II", 'overview': 'Professor Gabriel Emerson finally learns the truth ' "about Julia Mitchell's identity, but his " 'realization comes a moment too late. Julia is done ' 'waiting for the well-respected Dante specialist to ' 'remember her and wants nothing more to do with him. ' 'Can Gabriel win back her heart before she finds ' "love in another's arms?", 'popularity': 9.491, 'poster_path': '/pci1ArYW7oJ2eyTo2NMYEKHHiCP.jpg', 'release_date': '2020-07-31', 'title': "Gabriel's Inferno Part II", 'video': False, 'vote_average': 8.9, 'vote_count': 915}, ...もうすぐ公開される作品

pprint(api.get_upcoming_movies()) #=> {'dates': {'maximum': '2020-11-30', 'minimum': '2020-11-13'}, 'page': 1, 'results': [{'adult': False, 'backdrop_path': '/8rIoyM6zYXJNjzGseT3MRusMPWl.jpg', 'genre_ids': [14, 10751, 12, 35, 27], 'id': 531219, 'original_language': 'en', 'original_title': "Roald Dahl's The Witches", 'overview': 'In late 1967, a young orphaned boy goes to live ' 'with his loving grandma in the rural Alabama town ' 'of Demopolis. As the boy and his grandmother ' 'encounter some deceptively glamorous but thoroughly ' 'diabolical witches, she wisely whisks him away to a ' 'seaside resort. Regrettably, they arrive at ' "precisely the same time that the world's Grand High " 'Witch has gathered.', 'popularity': 1867.444, 'poster_path': '/betExZlgK0l7CZ9CsCBVcwO1OjL.jpg', 'release_date': '2020-10-26', 'title': "Roald Dahl's The Witches", 'video': False, 'vote_average': 7.1, 'vote_count': 530}, ...

- 投稿日:2020-11-08T20:49:54+09:00

Django シフト表に公開未公開機能を実装 希望シフトかの背景色コントロールも追加

シフト表機能を見てもらった時に、管理者である人がみんなの要望をラインとかで連絡してもらってから、かなり時間をかけながら作業していることがわかりました。

なので、作成途中のシフトは公開したくないということで、公開、未公開機能を実装しました。管理者が編集中であれば、状態は非公開になっているので公開ボタンが表示されています。

表示されていません。

コントロールは、Userのグループをうまく使うべきなのかもしれませんが、スーパーユーザーかどうかで判断しています。

モデルにフラグをもつことにして、それがONかOFFかで判断します。月テーブルをもつことも考えましたが、根本的に締め日とかいろいろ考えなおして作り変える時の考えようと思います。

まずはつかって喜んでもらえることが技術の習得を加速させると思っているので、頑張って実装を頑張ります(⌒∇⌒)

python.suchedule.modell.pyclass Schedule(models.Model): id = models.AutoField(verbose_name='スケジュールID',primary_key=True) user = models.ForeignKey(User, on_delete=models.CASCADE, verbose_name='社員名') date = models.DateField(verbose_name='日付') year = models.PositiveIntegerField(validators=[MinValueValidator(1),]) month = models.PositiveIntegerField(validators=[MaxValueValidator(12),MinValueValidator(1),]) shift_name_1 = models.ForeignKey(Shift, verbose_name='1シフト名', related_name='shift_name1',on_delete=models.SET_NULL,null= True) shisetsu_name_1 = models.ForeignKey(Shisetsu, verbose_name='1施設', related_name='shisetsu_name1',on_delete=models.SET_NULL,blank=True, null=True) shift_name_2 = models.ForeignKey(Shift, verbose_name='2シフト名', related_name='shift_name2',on_delete=models.SET_NULL,blank=True, null=True) shisetsu_name_2 = models.ForeignKey(Shisetsu, verbose_name='2施設', related_name='shisetsu_name2',on_delete=models.SET_NULL,blank=True, null=True) shift_name_3 = models.ForeignKey(Shift, verbose_name='3シフト名', related_name='shift_name3',on_delete=models.SET_NULL,blank=True, null=True) shisetsu_name_3 = models.ForeignKey(Shisetsu, verbose_name='3施設', related_name='shisetsu_name3',on_delete=models.SET_NULL,blank=True, null=True) shift_name_4 = models.ForeignKey(Shift, verbose_name='4シフト名', related_name='shift_name4',on_delete=models.SET_NULL,blank=True, null=True) shisetsu_name_4 = models.ForeignKey(Shisetsu, verbose_name='4施設', related_name='shisetsu_name4',on_delete=models.SET_NULL,blank=True, null=True) day_total_worktime = models.IntegerField(verbose_name='日労働時間', default=0) kibou_shift = models.BooleanField(verbose_name='希望シフト',default=False) open_flag = models.BooleanField(verbose_name='公開フラグ',default=False) class Meta: unique_together = ('user', 'date')python/schedule/month.html{% extends 'accounts/base.html' %} {% load static %} {% block customcss %} <link rel="stylesheet" href="{% static 'schedule/month.css' %}"> {% endblock customcss %} {% block header %} <div class="header"> <div class="cole-md-1"> <a href="{% url 'schedule:KibouList' %}" class="btn-secondary btn active">希望シフト一覧</a></p> {% ifnotequal month 1 %} <a href="{% url 'schedule:monthschedule' year month|add:'-1' %}" class="btn-info btn active">前月</a> {% else %} <a href="{% url 'schedule:monthschedule' year|add:'-1' 12 %}" class="btn-info btn active">前月</a> {% endifnotequal %} {% ifnotequal month 12 %} <a href="{% url 'schedule:monthschedule' year month|add:'1' %}" class="btn-info btn active">次月</a> {% else %} <a href="{% url 'schedule:monthschedule' year|add:'1' 1 %}" class="btn-info btn active">次月</a> {% endifnotequal %} </div> <!-- モーダルを開くボタン・リンク --> {% if perms.schedule.add_schedule %}<!--権限--> <button type="button" class="btn-info btn active" data-toggle="modal" data-target="#createModal">シフト作成</button> {% endif %} <!-- 作成確認 --> <div class="modal fade" id="createModal" tabindex="-1" role="dialog" aria-labelledby="basicModal" aria-hidden="true"> <div class="modal-dialog"> <div class="modal-content"> <div class="modal-header"> <h4><class="modal-title" id="myModalLabel">確認画面</h4></h4> </div> <div class="modal-body"> <label>シフト作成するとデータが上書きされますが実行しますか?</label> </div> <div class="modal-footer"> <button type="button" class="btn btn-default" data-dismiss="modal">閉じる</button> <a href="{% url 'schedule:schedulecreate' year month %}" class="btn-info btn active">シフト作成</a> </div> </div> </div> </div> <!-- モーダルを開くボタン・リンク --> {% if perms.schedule.add_schedule %}<!--権限--> {% if open_flag.open_flag == False %} <button type="button" class="btn-info btn active" data-toggle="modal" data-target="#openModal">公開</button> {% elif open_flag.open_flag == True %} <button type="button" class="btn-info btn active" data-toggle="modal" data-target="#closeModal">非公開</button> {% endif %} {% endif %} <!-- 公開確認 --> <div class="modal fade" id="openModal" tabindex="-1" role="dialog" aria-labelledby="basicModal" aria-hidden="true"> <div class="modal-dialog"> <div class="modal-content"> <div class="modal-header"> <h4><class="modal-title" id="myModalLabel">確認画面</h4></h4> </div> <div class="modal-body"> <label>シフト公開しますか?</label> </div> <div class="modal-footer"> <button type="button" class="btn btn-default" data-dismiss="modal">閉じる</button> {% ifnotequal month 12 %} <a href="{% url 'schedule:scheduleopen' year month %}" class="btn-info btn active">公開</a> {% else %} <a href="{% url 'schedule:scheduleopen' year|add:'1' month %}" class="btn-info btn active">公開</a> {% endifnotequal %} </div> </div> </div> </div> <!-- 非公開確認 --> <div class="modal fade" id="closeModal" tabindex="-1" role="dialog" aria-labelledby="basicModal" aria-hidden="true"> <div class="modal-dialog"> <div class="modal-content"> <div class="modal-header"> <h4><class="modal-title" id="myModalLabel">確認画面</h4></h4> </div> <div class="modal-body"> <label>シフト非公開にしますか?</label> </div> <div class="modal-footer"> <button type="button" class="btn btn-default" data-dismiss="modal">閉じる</button> {% ifnotequal month 12 %} <a href="{% url 'schedule:scheduleclose' year month %}" class="btn-info btn active">非公開</a> {% else %} <a href="{% url 'schedule:scheduleclose' year|add:'1' month %}" class="btn-info btn active">非公開</a> {% endifnotequal %} </div> </div> </div> </div> <div class="cole-md-2"> {% for shift in shift_object %} {% if shift.name != "休" and shift.name != "有" %} {{ shift.name }} : {{ shift.start_time | date:"G"}}~{{ shift.end_time | date:"G"}} {% endif %} {% endfor %} </div> <p> <a href="{% url 'schedule:monthschedule' year month %}" button type="button" class="btn btn-outline-dark">すべて</a> {% for shisetsu in shisetsu_object %} {% for UserShozoku in UserShozoku_list %} {% if shisetsu.name|stringformat:"s" == UserShozoku.shisetsu_name|stringformat:"s" %} <a href="{% url 'schedule:monthschedulefilter' year month shisetsu.pk %}" button type="button" class="btn btn-outline-dark" span style="background-color:{{ shisetsu.color }}">{{ shisetsu.name }}</span></a> {% endif %} {% endfor %} {% endfor %} </p> </div> {% endblock header %} {% block content %} <table class="table"> <thead> <tr> <!--日付--> <th class ="fixed00" rowspan="2">{{ kikan }}</th> {% for item in calender_object %} <th class ="fixed01">{{ item.date | date:"d" }}</th> {% endfor %} <tr> <!--曜日--> {% for item in youbi_object %} <th class ="fixed02">{{ item }}</th> {% endfor %} </tr> </thead> <tbody> {% if perms.schedule.add_schedule or open_flag.open_flag == True %}<!--権限--> {% for profile in profile_list %} {% for staff in user_list %} {% if profile.user_id == staff.id %} <tr align="center"> <th class ="fixed03" ><a href="{% url 'schedule:monthschedulekojin' year month staff.id %}">{{ staff.last_name }} {{ staff.first_name }}</a></th> <!--staff_id要素はjsで使う--> {% for item in object_list %} {% if item.user|stringformat:"s" == staff.username|stringformat:"s" %}<!--usernameが同一なら--> {% if item.kibou_shift == True %} <td class="meisai03"> {% elif item.shift_name_1|stringformat:"s" == "休" %} <td class="meisai01"> {% elif item.shift_name_1|stringformat:"s" == "不" %} <td class="meisai04"> {% else %} <td class="meisai01"> {% endif %} {% if item.shift_name_1 != None %} {% if item.shift_name_1|stringformat:"s" == "有" %} {{ item.shift_name_1 }} {% elif item.shift_name_1|stringformat:"s" == "休" %} {% elif item.shift_name_1|stringformat:"s" == "不" %} {{ item.shift_name_1 }} {% else %} <span style="background-color:{{ item.shisetsu_name_1.color }}">{{ item.shift_name_1 }}</span> {% endif %} {% endif %} {% if item.shift_name_2 != None %} {% if item.shift_name_2|stringformat:"s" == "有" or item.shift_name_2|stringformat:"s" == "休" %} {{ item.shift_name_2 }} {% else %} <span style="background-color:{{ item.shisetsu_name_2.color }}">{{ item.shift_name_2 }}</span> {% endif %} {% endif %} {% if item.shift_name_3 != None %} {% if item.shift_name_3|stringformat:"s" == "有" or item.shift_name_3|stringformat:"s" == "休" %} {{ item.shift_name_3 }} {% else %} <span style="background-color:{{ item.shisetsu_name_3.color }}">{{ item.shift_name_3 }}</span> {% endif %} {% endif %} {% if item.shift_name_4 != None %} {% if item.shift_name_4|stringformat:"s" == "有" or item.shift_name_4|stringformat:"s" == "休" %} {{ item.shift_name_4 }} {% else %} <span style="background-color:{{ item.shisetsu_name_4.color }}">{{ item.shift_name_4 }}</span> {% endif %} {% endif %} {% endif %} {% endfor %} </td> <tr align="center"> {% for month in month_total %} {% if month.user == staff.id %}<!--usernameが同一なら--> {% if perms.schedule.add_schedule %}<!--権限--> <td class="fixed04"><b>{{ month.month_total_worktime }}</b></td> {% else %} <td class="fixed04"><b>―</b></td> {% endif %} {% endif %} {% endfor %} {% for item in object_list %} {% if item.user|stringformat:"s" == staff.username|stringformat:"s" %}<!--usernameが同一なら--> {% if perms.schedule.add_schedule %}<!--権限--> <td class="meisai02" id="s{{ staff.id }}d{{ item.date }}"> <a href="{% url 'schedule:update' item.pk %}">{{ item.day_total_worktime }} </a> </td> {% else %} <td class="meisai02" id="s{{ staff.id }}d{{ item.date }}"> {% if item.day_total_worktime != 0 %} {{ item.day_total_worktime }} {% endif %} </td> {% endif %} {% endif %} {% endfor %} </tr> {% endif %} {% endfor %} {% endfor %} </tbody> </table> </div> </div> {% endif %} {% endblock content %}実際使う人とどれだけコミュニケーションをとって想像力(妄想力)を働かせて検討するかが大切だと痛感しました。

- 投稿日:2020-11-08T20:40:58+09:00

PyTorchでDeepChemのConvMolFeaturizerでfeaturizeしたミニバッチを返すDataLoaderを実装する

はじめに

Keras, TensorflowからPyTorchに乗り換え、化合物によるGraph Convolutional Network(GCN)を実装することとした。

まずは、SMILESで表される化合物を学習に利用できる形に変換する必要がある。

これらの処理を自前で実装してもよいが、Keras, Tensorflow ベースのライブラリである DeepChem の前処理を流用すれば楽ができると考えた。

そこで SMILES を DeepChem の ConvMolFeaturizer で feturize し、それを Pytorch の DataLoaderで使えるようにする。

これにより、面倒な化合物のハンドリング処理を自前で実装することなく、PyTorchでGCNの実装ができると考えている。環境

- PyTorch 1.7.0

実装方法

- Datasetは、単純にSMILESと正解データのリストを保持するものとした。

- ミニバッチ毎に、ミニバッチ内の全化合物をグラフに変換し、結合次数行列や、隣接行列を生成する必要があるため、collate_fn を独自に実装し、DataLoader の引数に与えることとした。

- collate_fn では、DeepChem の ConvMolFeaturizer によりSMILES を featulize しリスト化したものを、ConvMolクラスのagglomerate_molsメソッドに与える。これによりミニバッチ内の全化合物の結合次数行列、隣接行列が生成されるため、それぞれPyTorchのテンソル形式に変換し、正解データと共に返却している。

ソース

import torch from torch.utils import data from deepchem.feat.graph_features import ConvMolFeaturizer from deepchem.feat.mol_graphs import ConvMol class GCNDataset(data.Dataset): def __init__(self, smiles_list, label_list): self.smiles_list = smiles_list self.label_list = label_list def __len__(self): return len(self.smiles_list) def __getitem__(self, index): return self.smiles_list[index], self.label_list[index] def gcn_collate_fn(batch): from rdkit import Chem cmf = ConvMolFeaturizer() mols = [] labels = [] for sample, label in batch: mols.append(Chem.MolFromSmiles(sample)) labels.append(torch.tensor(label)) conv_mols = cmf.featurize(mols) multiConvMol = ConvMol.agglomerate_mols(conv_mols) atom_feature = torch.tensor(multiConvMol.get_atom_features(), dtype=torch.float64) deg_slice = torch.tensor(multiConvMol.deg_slice, dtype=torch.float64) membership = torch.tensor(multiConvMol.membership, dtype=torch.float64) return atom_feature, deg_slice, membership, labels def main(): dataset = GCNDataset(["CCC", "CCCC", "CCCCC"], [1, 0, 1]) dataloader = data.DataLoader(dataset, batch_size=3, shuffle=False, collate_fn =gcn_collate_fn) for atom_feature, deg_slice, membership, labels in dataloader: print(atom_feature) print(deg_slice) print(membership) if __name__ == "__main__": main()実行結果

3化合物によるミニバッチの結果は以下の通りとなる。

3化合物内の12原子の特徴および、結合次数行列、隣接行列が生成される。

結合次数行列、隣接行列の解説は別の機会に説明する。tensor([[1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 1., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 1., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 1., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 1., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 1., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 1., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 1., 0., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 1., 0., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 1., 0., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 1., 0., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 1., 0., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 1., 0., 0.]], dtype=torch.float64) tensor([[ 0., 0.], [ 0., 6.], [ 6., 6.], [12., 0.], [12., 0.], [12., 0.], [12., 0.], [12., 0.], [12., 0.], [12., 0.], [12., 0.]], dtype=torch.float64) tensor([0., 0., 1., 1., 2., 2., 0., 1., 1., 2., 2., 2.], dtype=torch.float64)今後

今後は、GCNのモデルをPyTorchで生成し、今回のDataLoaderを用いて予測モデルを作成していく。

- 投稿日:2020-11-08T20:40:58+09:00

DeepChemのConvMolFeaturizerでfeaturizeしたミニバッチを返すPyTorchのDataLoaderを実装する

はじめに

Keras, TensorflowからPyTorchに乗り換えることとした。

そして、PyTorchを使って化合物によるGraph Convolutional Network(GCN)を実装することとした。

まずは、SMILESで表される化合物を学習に利用できる形に変換する必要がある。

これらの処理を自前で実装してもよいが、Keras, Tensorflow ベースのライブラリである DeepChem の前処理を流用すれば楽ができると考えた。

そこで SMILES を DeepChem の ConvMolFeaturizer で feturize し、それを Pytorch の DataLoaderで使えるようにしてみた。

これにより、面倒な化合物のハンドリング処理を自前で実装することなく、GCNの実装に集中することができると目論んでいる。環境

- PyTorch 1.7.0

- DeepChem 2.3

実装方法

- Datasetは、単純にSMILESと正解データのリストを保持するものとした。

- ミニバッチ毎に、ミニバッチ内の全化合物をグラフに変換し、結合次数行列や、隣接行列を生成する必要があるため、collate_fn を独自に実装し、DataLoader の引数に与えることとした。

- collate_fn では、DeepChem の ConvMolFeaturizer によりSMILES を featulize しリスト化したものを、ConvMolクラスのagglomerate_molsメソッドに与える。これによりミニバッチ内の全化合物の結合次数行列、隣接行列が生成されるため、それぞれPyTorchのテンソル形式に変換し、正解データと共に返却している。

ソース

import torch from torch.utils import data from deepchem.feat.graph_features import ConvMolFeaturizer from deepchem.feat.mol_graphs import ConvMol class GCNDataset(data.Dataset): def __init__(self, smiles_list, label_list): self.smiles_list = smiles_list self.label_list = label_list def __len__(self): return len(self.smiles_list) def __getitem__(self, index): return self.smiles_list[index], self.label_list[index] def gcn_collate_fn(batch): from rdkit import Chem cmf = ConvMolFeaturizer() mols = [] labels = [] for sample, label in batch: mols.append(Chem.MolFromSmiles(sample)) labels.append(torch.tensor(label)) conv_mols = cmf.featurize(mols) multiConvMol = ConvMol.agglomerate_mols(conv_mols) atom_feature = torch.tensor(multiConvMol.get_atom_features(), dtype=torch.float64) deg_slice = torch.tensor(multiConvMol.deg_slice, dtype=torch.float64) membership = torch.tensor(multiConvMol.membership, dtype=torch.float64) return atom_feature, deg_slice, membership, labels def main(): dataset = GCNDataset(["CCC", "CCCC", "CCCCC"], [1, 0, 1]) dataloader = data.DataLoader(dataset, batch_size=3, shuffle=False, collate_fn =gcn_collate_fn) for atom_feature, deg_slice, membership, labels in dataloader: print(atom_feature) print(deg_slice) print(membership) if __name__ == "__main__": main()実行結果

3化合物によるミニバッチは以下の通りとなる。

3化合物内の12原子の特徴および、結合次数行列、隣接行列が生成される。

これらについては別の機会に説明する。tensor([[1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 1., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 1., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 1., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 1., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 1., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 1., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 1., 0., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 1., 0., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 1., 0., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 1., 0., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 1., 0., 0.], [1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 1., 0., 0.]], dtype=torch.float64) tensor([[ 0., 0.], [ 0., 6.], [ 6., 6.], [12., 0.], [12., 0.], [12., 0.], [12., 0.], [12., 0.], [12., 0.], [12., 0.], [12., 0.]], dtype=torch.float64) tensor([0., 0., 1., 1., 2., 2., 0., 1., 1., 2., 2., 2.], dtype=torch.float64)今後

今後は、GCNモデルのコード、および今回のDataLoaderを用いて学習を行うコードを書いていく。

感想

Kerasの窮屈感、Tensorflowのそっけなさに比べ、PyTorchの丁度良さがすごく心地いい(今のところ)。

- 投稿日:2020-11-08T20:22:13+09:00

Google Colabで今使っているNotebook名を取得する方法

Stackoverflowに回答がありました。

from requests import get filename = get('http://172.28.0.2:9000/api/sessions').json()[0]['name']

- 投稿日:2020-11-08T20:06:24+09:00

「画像でゴミ分類!」アプリ作成日誌day1~データセットの作成~

はじめに

みなさん、ごみの分類についてどれぐらい知っていますか?

たとえば、旅行の際には手放せない延長コード。デスク周りでも大活躍していることと思います。そんな、延長コードですが例えば接触不良で使えなくなってしまって捨てるとき、あなたは何ごみに捨てていますか?

適当に可燃ごみとして捨ててしまいますか?

答えは資源品(金属類)と筆者の住む地域ではなっていますが、正確には市町村によって異なります。

例えば横浜市では可燃ごみだそうです。また、流山市では不燃ごみとして扱われるようです。

このように同じごみでも捨て方は焼却設備や人口(すなわち出るごみの量)によって異なりますが、皆さんはゴミを正しく捨てているでしょうか?ゴミの出し方を熟知している人は少ないでしょうし、ましてや引越しなんかをして捨て方が変わった日には全部一から確認しなければなりません。

そこで、ごみの写真を撮れば適切な分類を教えてくれるwebアプリを作っていこうと思い立ちました。せっかくなので、この経過を日誌という形で記録をつけていきたいと思います。もしよければ続編を楽しみにしていただけると幸いです。

作るアプリの説明

まず、写真を撮ったらゴミの分類が表示されるところが最低限のやりたいことになります。分類の基準はとりあえず筆者の住んでいる柏市のものとします(需要があればもっと広げたいな)。

また、分類だけでなく出し方など、出す際の注意点も表示できるようにしたいです。

もっと言えば、自動でカレンダーに追加して通知する機能なんかをつけられると最高です。

上記のようなことをイメージしながら開発していきたいと思います。具体的な流れ

- データセットの作成

- モデルの作成(VGG16をfine tuning)

- バックエンドの実装(Django)

- フロントエンドの実装(HTML,CSS,Bootstrap)

- カレンダーに追加する機能の作成

こんな感じで行きたいと思います。

データセットの作成

まず初日はデータセットを作成していきたいと思います。選択肢は以下の3点です

- 既存のデータセットを転用する

- スクレイピング

- 自作

結論から言うと、今回は自作しようと思います。理由は自分が利用することを考えてなるべく身の回りにあるものを分類できるようになりたいことが一番の理由です。また、ほかの方法だと、既存のデータセットには家庭ゴミとしてありそうなものがあまり含まれていないこと(当然ですね)、スクレイピングは意外と検索結果に違うものが含まれてしまうことから断念しました。しかし、自作できるデータの数は限られているので、もっとデータ増やしたいと思ったらスクレイピングすると思います。

写真を撮る

データセットを作るために写真を撮っていきます。

PETボトル ティッシュ(未使用) 電池 こんな感じで写真を撮り終えました。合計499枚です。2,3時間撮り続けてだいぶ大変だったのに意外と集まってない…水増しで頑張ります泣

フォルダ構造

画像のフォルダ構成はこのようにしておきます。

train

├可燃ごみ

│ └画像たち(以下同様)

├資源品

├不燃ごみ

├包装容器プラスチック類

└有害ごみ

val

├可燃ごみ

│ └画像たち(以下同様)

├資源品

├不燃ごみ

├包装容器プラスチック類

└有害ごみこれはモデルを作る際に分類を自動で生成してもらえるようにこのような構成にしています。

githubリポジトリ

このアプリの開発はgithubを使って行おうと思います。リンク( https://github.com/eycjur/garbage )です。

さて、初日はこんなもんで締めたいと思います。

次回も楽しみにしていてください

- 投稿日:2020-11-08T18:52:54+09:00

営業職からMOOCsを利用して機械学習エンジニアを目指す

はじめに

-年齢: 35歳 (2020年現在)

-キャリア: 新卒から11年ほどソフトウェアの営業職、直近7年は外資のセールスに従事(業務でプログラミングを行う機会は無し)

-きっかけ: 転職とコロナ禍での新しい働き方を真剣に実現するためにプログラミングの学習を開始。

主にデータサイエンス、AI/ML領域のエンジニアを目指し日々勉強の記録を残していきます。これまでの学習経緯

2018

- Progate (HTML, CSS, Python)

- Tech Academy Python/AIコース 終了

- Coursera Machine Learning Course →挫折

しかし、その後何かプロダクトを作るわけでもなく、仕事で使うわけでもなく、お勉強で終了。2020

- PyQ (Python)

- Udemy (Python, HTML, CSS)

- ドットインストール (HTML, CSS)上記を経て2020年9月以降からMOOCs(Massive Open Online Courses)を利用した学習を開始

MOOCsとは

https://education-career.jp/magazine/data-report/2016/moocs/2020.09~

- edX: Python for Everybody 終了

- Udacity: Programming for Data Science with Python ★取組中

https://www.udacity.com/course/programming-for-data-science-nanodegree--nd104なぜMOOCsを利用?

自分がプログラミングで何をやりたいのかが定まっていなかったこともありますが、プログラミング学校や各プログラミング学習サイトでは

「ある言語を習得する」為にプログラムが組まれており、ポイントポイントでの学習となってしまっていました。

結果、なんとなくわかった気にはなるが、自分で何か成果物を作れるレベルには全く至らないということを繰り返していました。また、改めてプログラミングスクールを受けるには費用面もあり今回の選択肢には入っていないので、ある程度手頃な値段で無数にある学習コンテンツから学んでいこうと考えました。

なぜ今Udacityで学習している?

■企業運営でより実務にフォーカスしている

Udacityは本格的にMOOCsを調べ始めてから知りましたが、Udacityでは各言語を習得する為ではなく、各業務、キャリアで必要となるスキルをセットにして一つのコースが組まれています。

例えば今学んでいるProgramming for Data Science with Pythonのプログラムは以下のようなものです。

- Introduction to SQL

- Command Line Essentials

- Introduction to Python

- Introduction to Version Control

- Career Services

- Congratulations and Next Steps

Udacityは大学が中心となって運営されているCourseraやedXと違い、テクノロジー企業を中心に運営されている組織なので、企業での業務によりそった形でコースが組まれている点も魅力を感じました。CourseraやedXはいかにも大学の講義、という感じで、理論や各言語について学ぶというイメージです。

■nanodegree

また、nanodegreeという形でCertificationが発行され、Linkedinなどで訴求できるスキルとして残せる点も良いと思いました。

(日本のプログラミングスクールなどでの実績はLinkedinなどでは理解されないため、実績としては弱いと感じています)■費用面

日本のプログラミングスクールは30万~場所によっていは80万程度とそれなりの費用感となりますが、Udacityのコースは3ヶ月10万程度。

最初はキャンペーンを利用して50%offの5万程度で受講することができました。

CourseraやedXの1コース5,000程度(Certification発行代)と比べたら高いですが、UIやシラバスも非常にわかりやすく設計されており、費用以上の効果を感じています。■デメリット

デメリットは言うまでもなく、すべてのコースが英語で提供されている点です。

英語に抵抗がない方であれば問題ないですが、英語が苦手な方には難しいかもしれません。まとめ

オンライン学習であるMOOCsを利用して、どこまで独学で行けるかどうかを試してみようと思います。

まずはUdacityのProgramming for Data Science(Beginner)を終わらせた上で、AI Programming with Python(Beginner)、

Data Engineer or Data Analyst(Intermediate)、Machine Learning Engineer or Data Scientist(Advanced)といった順にレッスンを進めつつ、これまでおろそかになっていたポートフォリオづくりをしっかり進めたいと思います。

- 投稿日:2020-11-08T17:53:26+09:00

Windows の Atom の Pylint でエラーが出るとき

この記事について

結構いろんな原因でエラーが出るので、備忘録として書いていきます。

故障かな?と思ったら

pylint.exe への PATH は合っていますか?

過去記事:WindowsのAtomでPylint

コメントブロックに問題はありませんんか?

原因

コメントブロックに

\が含まれるとエラーになる。def your_function(): """ こんなふうに \ が含まれていると linter-pylint が機能しない """ pass解決策①

def your_function(): """ こんなふうに \\ すれば機能する。 """ pass解決策②

def your_function(): r""" こんなふうにraw文字列として設定 \ すれば機能する。 """ pass

- 投稿日:2020-11-08T17:41:59+09:00

seleniumを用いたiタウンページのスクレイピング

前書き

2020年頃に、iタウンページの仕様が変更されたので、それに対応したスクリプトを作成してみました。

作成するのは以下のようなスクリプトですキーワードとエリアを入力してiタウンページ上で検索→検索結果から店名と住所を取得してcsv形式で出力する

注意

※Webスクレイピングはサイトの利用規約などによって禁止されている可能性があります

今回の題材とするiタウンページでは以下が主に禁止されています

- iタウンページのサービスに多大な影響を与える行為

- 自動的にアクセスするプログラムを使用してiタウンページに繰り返しアクセスする行為

- 不正なプログラム・スクリプトなどを用いて、サーバーに負荷を与える行為

本記事で紹介するプログラムではユーザが通常利用する際の速度を大幅に上回るような速度での連続アクセスは行わないため、禁止事項には該当しない(と思われます)

また、第三者が閲覧可能な環境での利用のために複製することは禁じられているため、

説明の際にサイトの画像などは載せられませんあしからずiタウンページ

2020年頃にサイトが更新され、検索結果を下にスクロールしていくとさらに表示というボタンが出現し、

これを何度も押さなければ全ての検索結果(最大表示1000件)を取得できないようになりました。プログラム概要

とりあえずざっとした説明とプログラム全体を載せます。(詳しい説明は後述)

- 動作環境:

- Python3.9

- ライブラリ:

- selenium 3.141.0

- pandas 1.1.4

- PySimpleGUI 4.30.0

- beautifulsoup4 4.9.3

- ソフトウェア:

- Firefox 82.0.2

- geckodriver 0.28.0 (firefox使用時)

- Chrome 86.0.4240.183

- chromedriver 86.0.4240.22 (chrome使用時)

PysimpleGUIを使って入力インターフェースを作ります(なくても問題ありません)

seleniumのwebdriverを使用してchrome(or firefox)を起動し、該当ページを表示 & さらに表示ボタンを全部押します

beautifulsoupを使って必要な要素を取得します(今回は店名と住所の2種類)

pandasを使ってデータを成形しますmain.py#It is python3's app #install selenium, beautifulsoup4, pandas with pip3 #download firefox, geckodriver from selenium import webdriver #from selenium.webdriver.firefox.options import Options from selenium.webdriver.chrome.options import Options from selenium.common.exceptions import NoSuchElementException from bs4 import BeautifulSoup import pandas as pd import time import re import csv import PySimpleGUI as sg #plese download browserdriver and writedown driver's path #bdriverpath='./chromedriver' bdriverpath="C:\chromedriver.exe" #make popup window layout= [ [sg.Text('Area >> ', size=(15,1)), sg.InputText('町田')], [sg.Text('Keyword >> ', size=(15,1)), sg.InputText('コンビニ')], [sg.Submit(button_text='OK')] ] window = sg.Window('Area and Keyword', layout) #popup while True: event, values = window.read() if event is None: print('exit') break if event == 'OK': show_message = "Area is " + values[0] + "\n" show_message += "Keyword is " + values[1] + "\n" print(show_message) sg.popup(show_message) break window.close() area =values[0] keyword = values[1] #initialize webdriver options = Options() options.add_argument('--headless') driver=webdriver.Chrome(options=options, executable_path=bdriverpath) #search page with keyword and area driver.get('https://itp.ne.jp') driver.find_element_by_id('keyword-suggest').find_element_by_class_name('a-text-input').send_keys(keyword) driver.find_element_by_id('area-suggest').find_element_by_class_name('a-text-input').send_keys(area) driver.find_element_by_class_name('m-keyword-form__button').click() time.sleep(5) #find & click readmore button try: while driver.find_element_by_class_name('m-read-more'): button = driver.find_element_by_class_name('m-read-more') button.click() time.sleep(1) except NoSuchElementException: pass res = driver.page_source driver.quit() #output with html with open(area + '_' + keyword + '.html', 'w', encoding='utf-8') as f: f.write(res) #parse with beautifulsoup soup = BeautifulSoup(res, "html.parser") shop_names = [n.get_text(strip=True) for n in soup.select('.m-article-card__header__title')] shop_locates = [n.get_text(strip=True) for n in soup.find_all(class_='m-article-card__lead__caption', text=re.compile("住所"))] #incorporation lists with pandas df = pd.DataFrame([shop_names, shop_locates]) df = df.transpose() #output with csv df.to_csv(area + '_' + keyword + '.csv', quoting=csv.QUOTE_NONE, index=False, encoding='utf_8_sig') sg.popup("finished")ブロック毎に解説

環境構築

以下が今回impoprtしたライブラリ群です。

全てpip3でインストールできます。

コメントアウトしているのは、chromeを使用するかfirefoxを使用するかの部分ですので、好みと環境に合わせて書き換えてください。import.pyfrom selenium import webdriver #from selenium.webdriver.firefox.options import Options from selenium.webdriver.chrome.options import Options from selenium.common.exceptions import NoSuchElementException from bs4 import BeautifulSoup import pandas as pd import time import re import csv import PySimpleGUI as sgdriver

この後解説するwebdriverを使用する場合には、chromeならchromedriver、firefoxならgeckodriverが必要になります。

該当するものを下記サイトからダウンロードしてください。

https://github.com/mozilla/geckodriver/releases

https://chromedriver.chromium.org/downloads

また、このとき自分の使用しているブラウザ、python、driverの3つのバージョンが噛み合っていないと動作しません

- まずブラウザは基本的に最新のものを使用してください

- driverはそれに合わせてダウンロードしましょう

- geckoなら最新を使用する(たぶん)

- chromeならchromeのバージョン名とdriverのバージョン名が連動しているので、同じものを選ぶ

ドライバをダウンロードしたら環境変数としてpathを通すか、わかりやすい場所に置いてプログラム内でpathを書きます。

私のwindows環境ではCドライブ直下に置いています。

コメントアウトしていますが、linux(mac)ではプログラムが置いてある場所と同じ場所に置いて使用しました。driver.py#plese download browserdriver and writedown driver's path #bdriverpath='./chromedriver' bdriverpath="C:\chromedriver.exe"PySimpleGUI

参考文献

Tkinterを使うのであればPySimpleGUIを使ってみたらという話レイアウトを決定し、デフォルトの入力を書いておきます(町田、コンビニ)

layout.py#make popup window layout= [ [sg.Text('Area >> ', size=(15,1)), sg.InputText('町田')], [sg.Text('Keyword >> ', size=(15,1)), sg.InputText('コンビニ')], [sg.Submit(button_text='OK')] ]

ウィンドウを作成し、ループで読み込み続けます。

ウィンドウにあるOKボタンがおされると、入力内容がvalues[]に読み込まれます。

処理終了後はwindow.close()で終了し、プログラム内の変数に入力内容を渡します。window.pywindow = sg.Window('Area and Keyword', layout) #popup while True: event, values = window.read() if event is None: print('exit') break if event == 'OK': show_message = "Area is " + values[0] + "\n" show_message += "Keyword is " + values[1] + "\n" print(show_message) sg.popup(show_message) break window.close() area =values[0] keyword = values[1]webdriverの起動

webdriver(selenium)は通常のブラウザ(firefox, chrome等)をプログラムから操作するためのライブラリです

まず起動時のオプションに

--headlessを追加します。これはブラウザをバックグラウンド実行にするオプションです。

もしブラウザが自動で動く様子がみたい場合はoptions.add_argument('--headless')をコメントアウトしてください。

次に、driver=webdriver.Chrome()でchromeを起動します。

同時にoptionと、driverのパスを入力します。options=options, executable_path=briverpathinit.py#initialize webdriver options = Options() options.add_argument('--headless') driver=webdriver.Chrome(options=options, executable_path=briverpath)webdriverで検索

driver.getでタウンページのトップにアクセスします。

driver.find~でキーワードとエリアを入力するinputボックスを探して、.send_keys()で入力も行います。

また、同じ方法で検索開始ボタンも探して、.click()でボタンを押します。

※htmlは、chrome等でiタウンページのサイト開いた状態でデベロッパーツール(ソースを見る)などすると見せてくれます。search.py#search page with keyword and area driver.get('https://itp.ne.jp') driver.find_element_by_id('keyword-suggest').find_element_by_class_name('a-text-input').send_keys(keyword) driver.find_element_by_id('area-suggest').find_element_by_class_name('a-text-input').send_keys(area) driver.find_element_by_class_name('m-keyword-form__button').click() time.sleep(5)htmlの例

例えば以下のページでは、キーワードの入力ボックスがあるのはidが