- 投稿日:2021-02-25T23:18:16+09:00

GoogleColab での Janome を使用したテキスト解析と頻出単語の可視化

はじめに

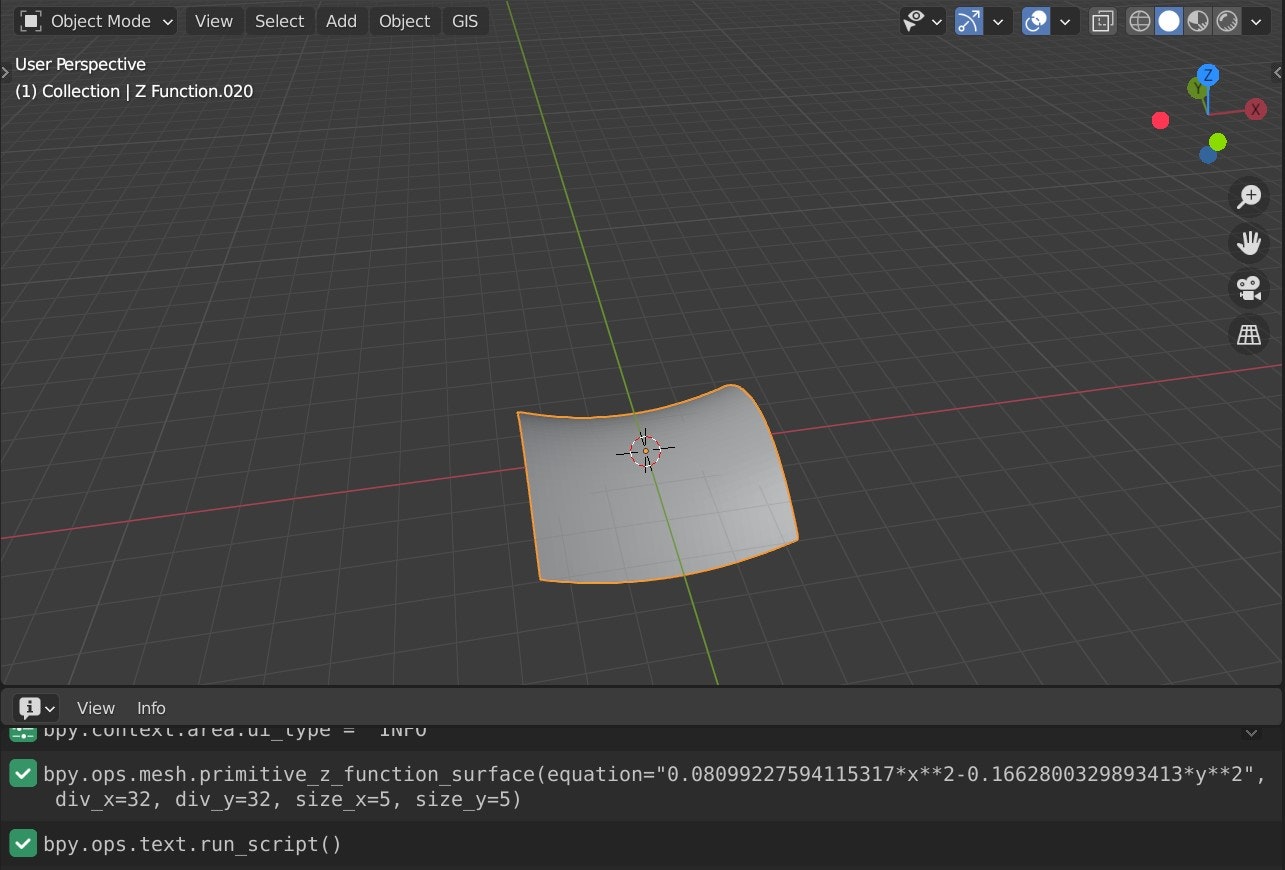

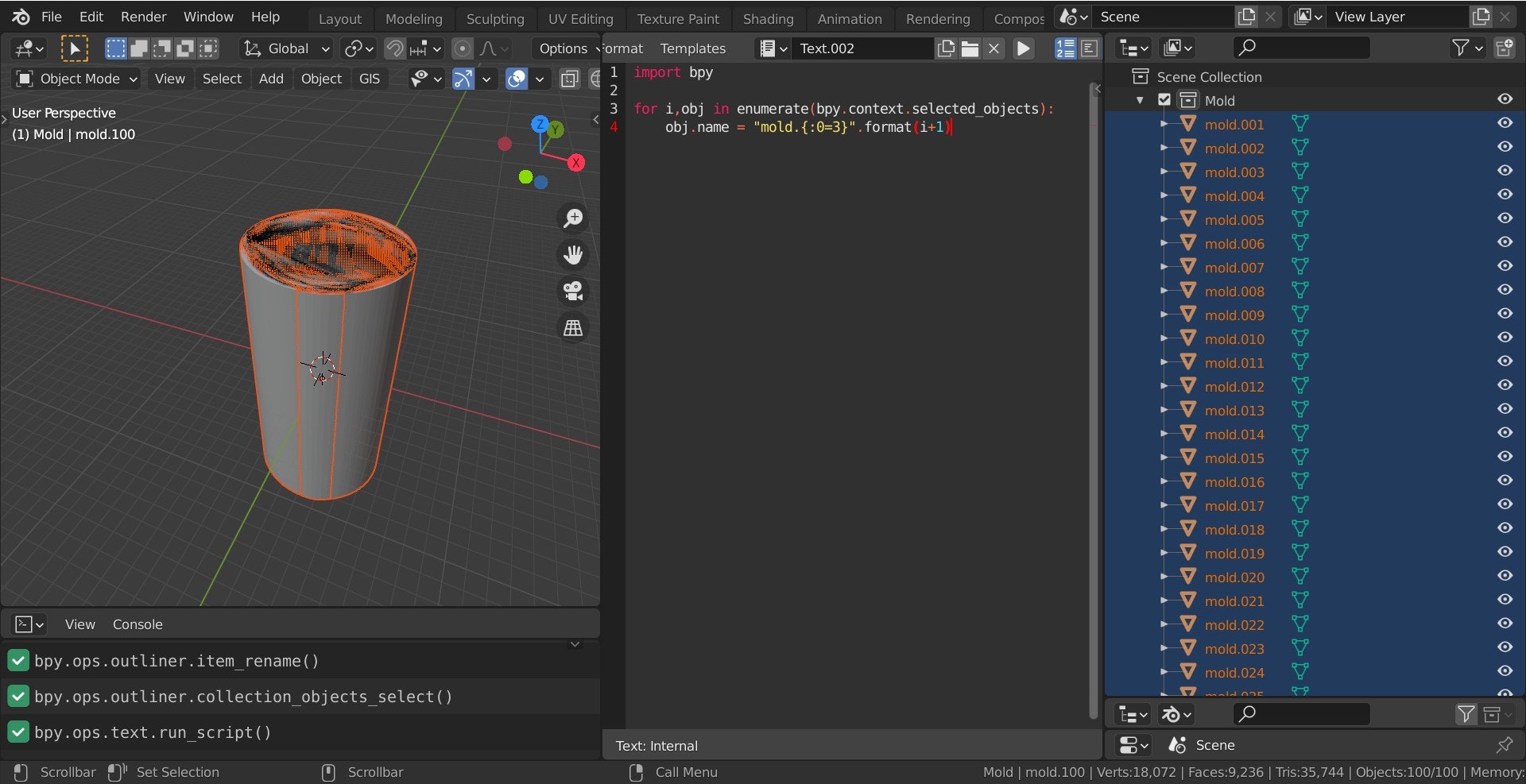

- AI について勉強したい、何かきっかけが欲しいなと本屋でブラブラしていたら出会った『人気ブロガーからあげ先生のとにかく楽しいAI自作教室』

- 環境準備が不要で、自分で実際に手を動かせるサンプルのサイズ感がよく、まずは日本語テキストの解析からチャレンジする

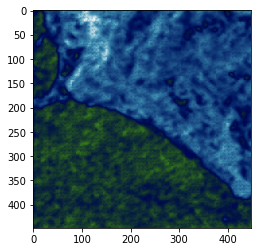

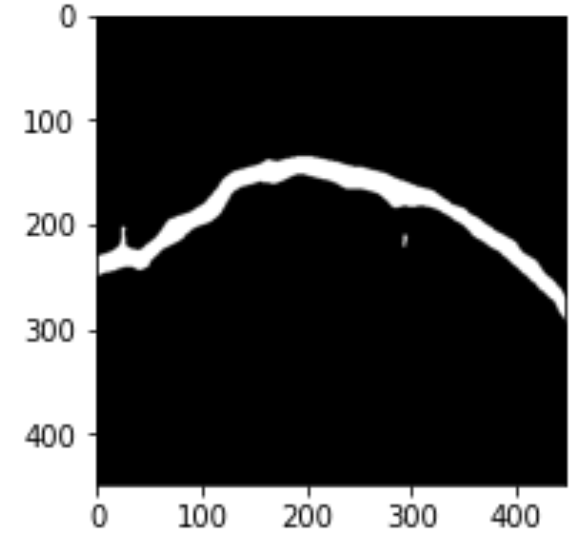

- 具体的には前述の書籍の 3 章に基づいて Google Colaboratory 上で青空文庫から取得した文章を Janome で形態素解析して名詞を抽出、 WordCloud で可視化するところまでを実施する

使用したツール類

Google Colaboratory

- Google が無料で提供しているブラウザベースで機械学習が行えるクラウドサービス

- ブラウザ上で全て完結して環境を気にせず簡易に実行できるのが実に良い

- この環境上で Python のコーディングや実行、可視化が行える

- 内容としては Colab がホストする Jupyter ノートブック

- GPU も使用可

- ただし、使用時間に制限があり 12 時間立つと環境がリセットされる

- 自分の Google Drive をマウントしてその上で作業すれば wget したものなどは保持される

- 最初はマウントすることを知らず wget したものなどが揮発してしまい難儀していた

- マウントに関しては下記がとても参考になった

- Google Colaboratory の詳細や操作方法に関しては下記がとても参考になった

Janome

- Python で使用可能な形態素解析ライブラリの一つ

- 日本語テキストを解析して品詞ごとに分かち書きできる (単語を区切って表示する)

WordCloud

- 文章内の単語を検出頻度に応じて大小をつけて表示する Python のライブラリ

やってみた (以降は全て Google Colaboratory 上で実施した)

事前準備1 (テキストファイルのダウンロード)

マウントした作業用ディレクトリに移動し、青空文庫から『吾輩は猫である』を取得して解凍する

%cd /content/drive/MyDrive/textData/ !wget https://github.com/aozorabunko/aozorabunko/raw/master/cards/000148/files/789_ruby_5639.zip !unzip 789_ruby_5639.zip !ls 789_ruby_5639.zip wagahaiwa_nekodearu.txt事前準備2 (テキストファイルの読み込み)

『吾輩は猫である』のテキストファイルを text_list へ全行読み込む

text_list = [] with open('wagahaiwa_nekodearu.txt', encoding='shift_jis') as f: text_list = f.readlines()Janome のセットアップ

インストールと version の確認

!pip install janome!janome --version janome 0.4.1Janome での形態素解析の実施

『吾輩は猫である』のテキストを格納した text_list を形態素解析し、名詞のみを抽出して分かち書きを行う

from janome.tokenizer import Tokenizer t = Tokenizer() words = [] for text in text_list: tokens = t.tokenize(text) for token in tokens: pos = token.part_of_speech.split(',')[0] if pos == '名詞': words.append(token.surface) text = ' '.join(words)解析結果の中身の一部を確認

『吾輩』という単語がみえ、正しく名詞を抽出できている様子

print(text[1000:1100]) 路 邸 しき 先 善 い うち 腹 さ 雨 始末 一刻 猶予 仕方 そう 方 方 今 時 家 内 の ここ 吾輩 彼 書生 以外 人間 機会 遭遇 ぐう の 一 の さん これ 前 書生 乱暴 方 吾WordCloud による可視化

WordCloud と日本語フォントのインストール

!apt -y install fonts-ipafont-gothic !pip install wordcloud及び、 Matplotlib のインポートし

from wordcloud import WordCloud import matplotlib.pyplot as plt実行

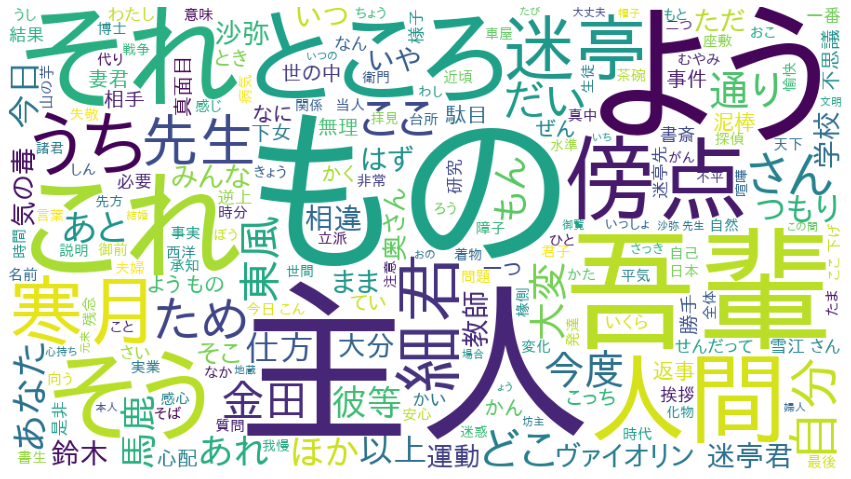

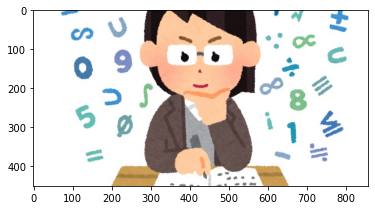

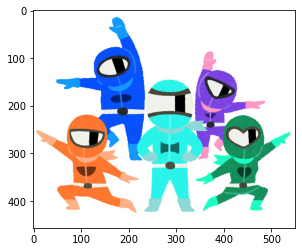

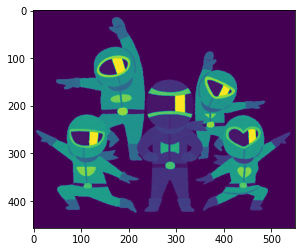

fpath = 'usr/share/fonts/opentype/ipafont-gothic/ipagp.ttf' wordcloud = WordCloud(background_color="white", font_path=fpath, width=900, height=500).generate(text) plt.figure(figsize=(15,12)) plt.imshow(wordcloud) plt.axis("off") plt.show()実行結果

フィルタの追加と再実行

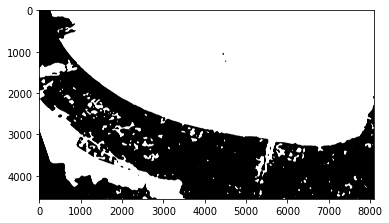

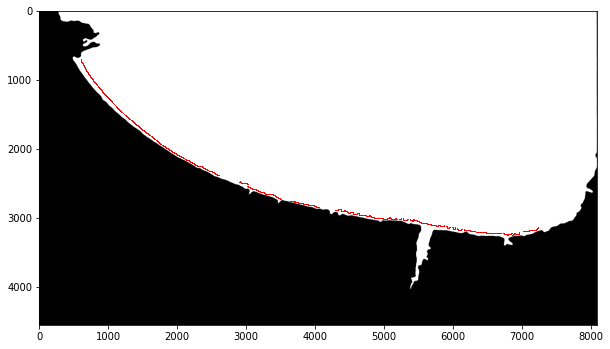

- 『吾輩は猫である』特有の頻出単語を検知したいので先述した処理に不要な単語を除外する remove_stopwords メソッドの追加とテキストを読み込むごとに実行するように改修した

- 再度『吾輩は猫である』のテキストファイルを text_list へ全行読み込む

text_list = [] with open('wagahaiwa_nekodearu.txt', encoding='shift_jis') as f: text_list = f.readlines()不要な単語を除外する remove_stopwords メソッドの定義

import re def remove_stopwords(text): text = re.sub(r'それ', "", text) text = re.sub(r'ところ', "", text) text = re.sub(r'これ', "", text) text = re.sub(r'そう', "", text) text = re.sub(r'さん', "", text) text = re.sub(r'あれ', "", text) text = re.sub(r'そこ', "", text) text = re.sub(r'ほか', "", text) text = re.sub(r'どこ', "", text) text = re.sub(r'よう', "", text) text = re.sub(r'もの', "", text) text = re.sub(r'うち', "", text) text = re.sub(r'ため', "", text) text = re.sub(r'いや', "", text) text = re.sub(r'こっち', "", text) text = re.sub(r'ここ', "", text) text.strip() return texttext_list から不要な単語を除外した結果を new_text_list に再度格納する

new_text_list = [] for text in text_list: text = remove_stopwords(text) new_text_list.append(text)『吾輩は猫である』のテキストから不要な単語を除外して改めて格納した new_text_list を形態素解析し、名詞のみを抽出して分かち書きを行う

from janome.tokenizer import Tokenizer t = Tokenizer() words = [] for text in new_text_list: tokens = t.tokenize(text) for token in tokens: pos = token.part_of_speech.split(',')[0] if pos == '名詞': words.append(token.surface) text = ' '.join(words)WordCloud の実行

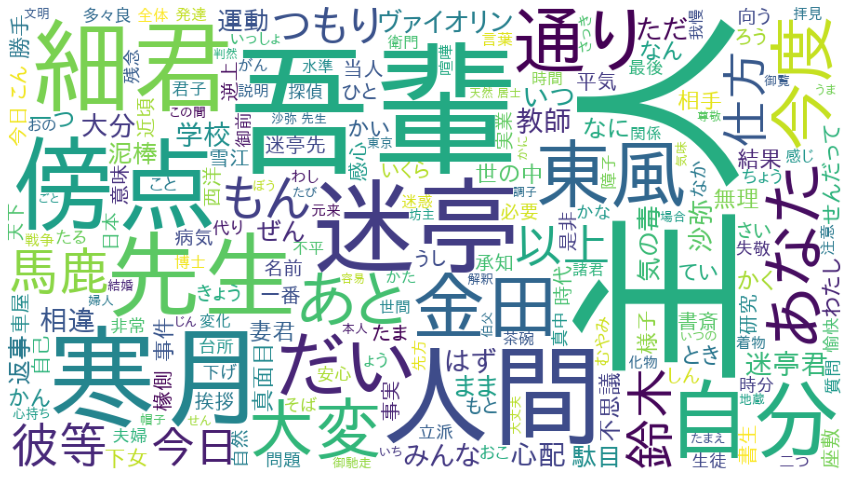

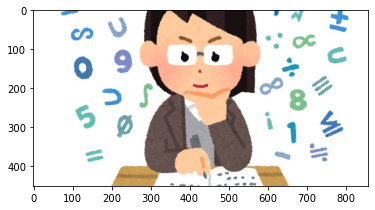

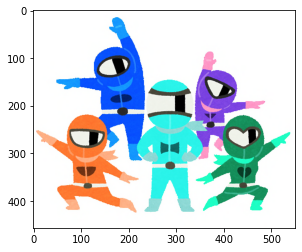

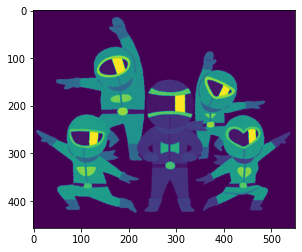

fpath = 'usr/share/fonts/opentype/ipafont-gothic/ipagp.ttf' wordcloud = WordCloud(background_color="white", font_path=fpath, width=900, height=500).generate(text) plt.figure(figsize=(15,12)) plt.imshow(wordcloud) plt.axis("off") plt.show()再実行結果

- 『主人』が最頻出の名詞で次点が『吾輩』となった

- 結果から想像するに、主役が『主人』で『吾輩』と適宜絡みがあり『細君』『傍点』『迷亭』『先生』『寒月』などが関わっていく物語だと思われる

おわりに

まずはこういったツール類を使用して機械学習がどういったものなのか掴んでいきたい

参考 書籍/URL:

- 投稿日:2021-02-25T22:45:51+09:00

【python3】import, from, as の違いについて

pythonの上に付いてる謎のやつ

importしか使っていなかったがfrom・asって一体なんぞや。ということで記入。

既に同じような記事があるかと思う。。記事内容

- import

- from

- as

import

pipでインストールしたパッケージ導入時に使用。以下の例の様にpythonにそもそもないものを使う時に使用する。

python使ってれば結構使うことになると思われ。てか直ぐ使うことになる。import datetime datetime.datetime.now()from

ここの階層に移動するとソース・ファイルがあるよーってのを教える時に使用する。

※ fromを使用する場合は.py付けない# 同一階層のhage.py を使用(関数aaaを呼び出す) import hage hage.aaa() # aaa/hige.py を使用(関数aaaを呼び出す) from aaa import hige hige.aaa() # 1つ上の階層のhuge.py を使用(関数aaaを呼び出す) from .. import huge huge.aaa()as

import, from で指定した内容を省略・名前変更する時に使用する。

import datetime as dt from ./ import hage as hage_light # 上のimportの例と同じだけど、このように短縮可能 dt.datetime.now()結論

実際使った方が早いと思う。

- 投稿日:2021-02-25T21:52:33+09:00

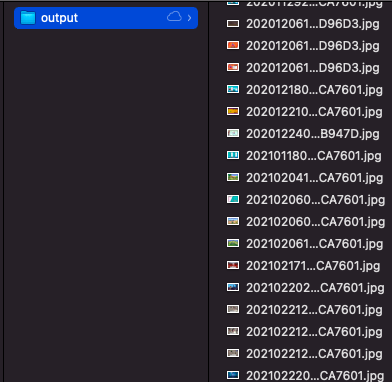

Nintendo Switchの画像をひとつのディレクトリに集結させたい

おうち時間の増加によってさらなる売上を伸ばしているらしいニンテンドースイッチ。

ゲーム画面のスクリーンショットをワンタッチで撮影することができるボタンを備えていて、撮影した写真をスマホに送ったり、直接SNSに投稿したりすることができます。

前提

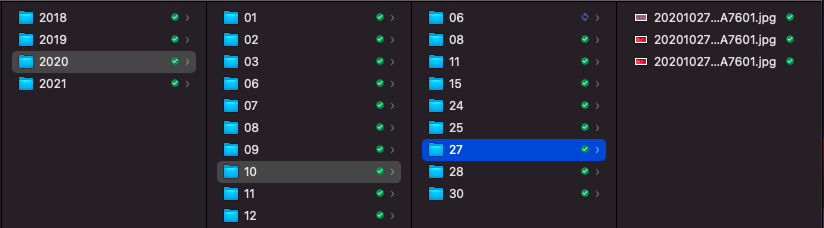

画像のディレクトリ構成

画像は本体またはSDカードに保存されますが、SDカードをPCに差し込んで中を除くと以下のようなディレクトリ構成になっていることがわかります。

年 / 月 / 日 / 年月日時間_xxxxxxxxx.jpgメリット

- 画像が撮影日ごとになっているのは単純にわかりやすい

- 「ああ、この時こんなソフトで遊んでたなあ」と思い出に更けやすい

デメリット

- 探したい画像がある場合に一覧で探せない(探しづらい)

- いちいち日付ディレクトリまでくだるのがめんどくさい

対象はSwitch二台分

僕はSwitchを二台持っているので、今回はそれぞれの画像ルートディレクトリを下記のような構成で配置しておきます。

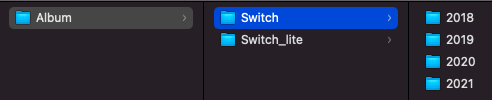

やりたいこと

下記のように、ひとつのディレクトリに全画像を集結させ、一覧性を高めたい!

方法

たぶんshellでもできるけど、なんとなくPythonを使ってみたい。

(Pythonならでは、じゃないのでPythonサイコー!とはなりません)ソースコード

初心者過ぎてコードを正しく解説できる自信はないし、何より「もっとこう書けるよ?」的な感じのご意見もあると思うのでさっさと結論を貼ります。

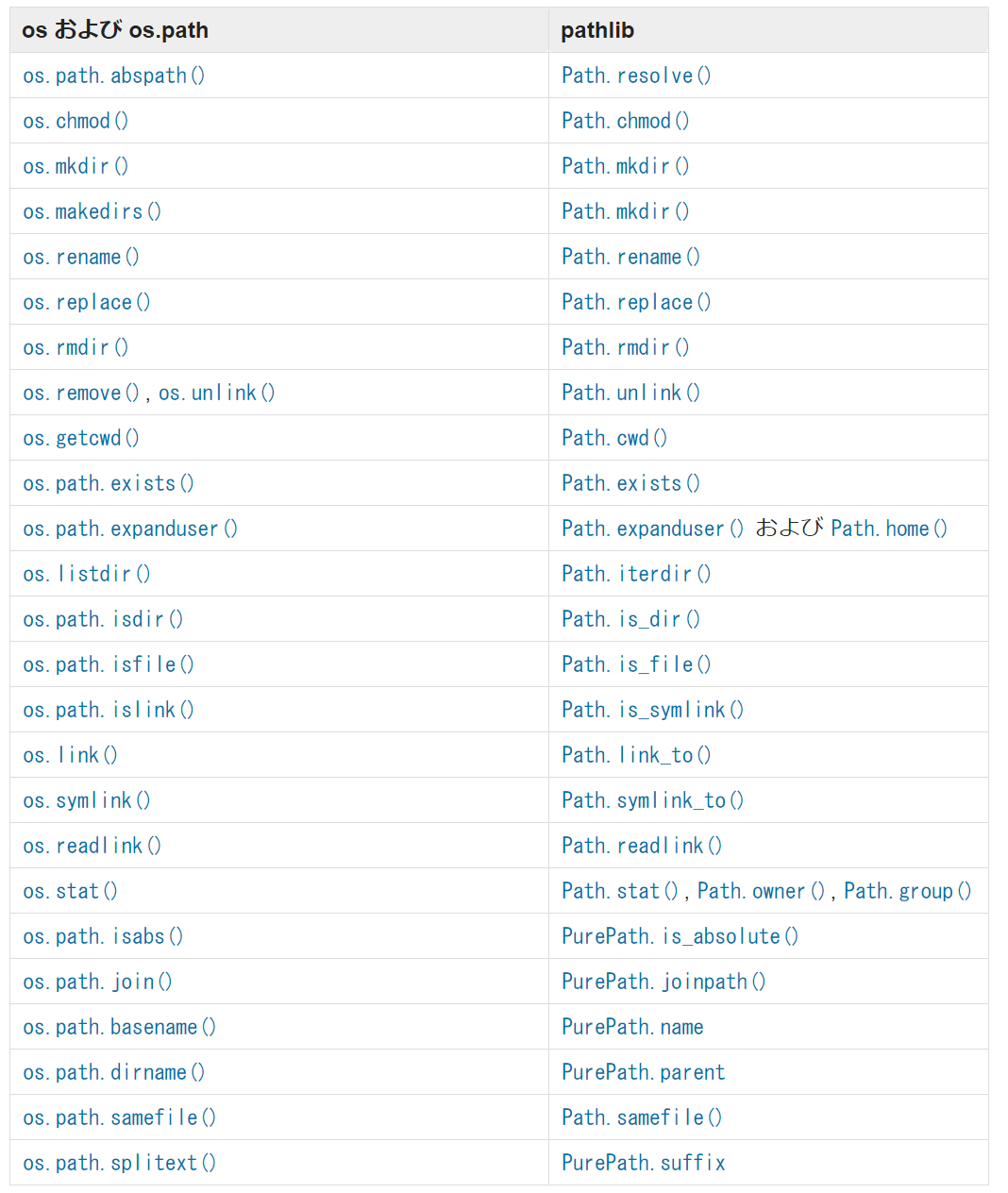

import os import glob import shutil from pathlib import Path # ベースディレクトリ base_dir = "/Users/hogehoge/Desktop/Game/Album" # なければ出力ディレクトリを作成 output_dir = "/Users/hogehoge/Desktop/output" Path(output_dir).mkdir(exist_ok=True) # ファイルコピー関数 def func(input_dir): # **/*.jpgにより、サブディレクトリまで探索 for i, img_path in enumerate(Path(input_dir).glob("**/*.jpg")): # 保存ファイルパス <output_dir>/<元のファイル名>.jpg save_path = Path(output_dir) / img_path.name # ファイルをコピー(img_path => save_path) shutil.copyfile(img_path, save_path) # なんとなく枚数カウント cnt =+ i print(cnt + 1) # 最後に枚数出力 if __name__ == '__main__': # ベース配下のディレクトリの絶対パスを取得(recursive = サブディレクトリまで見るかどうか) paths = map(os.path.abspath, glob.glob(base_dir + '/*', recursive=False)) # ディレクトリだけにフィルタリングして、listで返す paths = list(filter(os.path.isdir, paths)) # 1つずつ処理する for i, p in enumerate(paths): print('[%s / %s] Start %s' % (i + 1, len(paths), p)) func(p)ちょこっとだけ解説(備忘録)

Path("hoge/fugafuga")

Path(output_dir).mkdir(exist_ok=True)これにより与えられた文字列をディレクトリパスとして扱うことができるらしいです。

__name__

if __name__ == '__main__':プログラミングでよくある冒頭のおまじない的な感じです。(importされた時の挙動制御みたいな意味合いがあるらしいです)

ディレクトリのリストに対する操作諸々

paths = map(os.path.abspath, glob.glob(base_dir + '/*', recursive=False)) paths = list(filter(os.path.isdir, paths))最初の

map関数で、base_dir/*にあるファイルやディレクトリの絶対パス(abspath)を取得して、次のfilter関数で、pathsの中からディレクトリだけ(isdir)を取得します。(返却はlist型)今回は

base_dir配下に、SwitchとSwitch_liteという二つのフォルダがあるので、最終的なpathsは以下のようになりました(整形済み)。[ '/Users/hogehoge/Desktop/Game/Album/Switch_lite', '/Users/hogehoge/Desktop/Game/Album/Switch' ]enumerate(paths)

forループの中で使うとインデックス番号を取得できるらしいです。(以下の場合、iがインデックス番号)

for i, p in enumerate(paths):glob

glob.glob(base_dir + '/*', recursive=False) Path(input_dir).glob("**/*.jpg")同じ

glob関数ですが、前者はbase_dir/*配下のファイルやディレクトリ、後者はinput_dir配下の*.jpgファイルを再帰的に取得します。ちなみに、前者は後者のような書き方でも大丈夫そうです。ただ、どっちがいいかはわからないです。

Path(base_dir).glob("*")shutil.copyfile

shutil.copyfile(img_path, save_path)

img_pathをsave_pathにコピーするらしいです。shutilは読み方、エスエイチユーティルでいいのかな。

というわけで趣味の延長ですが、Nintendo Switchで撮影した画面キャプチャをもともとのディレクトリ構造からひとつのディレクトリに集結させるPythonを書いてみた話でした。

- 投稿日:2021-02-25T20:51:05+09:00

Python tutorial #1 文字列

文字列の操作

コメント

このコードは何に使っているんだろうかと困ることが将来よくあることであろう。そのことを防ぐためには、コメントという機能を用いることで対処できる。コメントとは実際に書いたものをコード自体に影響を及ぼさなない。つまりシステムになんの影響も与えないもののことである。よって実行しても何も起こらない。コメントのやり方は下のコードのように前に'#'をつけることである。

#これはコメントです。'\'によるエスケープ

特定の文字の前に\を入れるといろいろな処理を行うことができる。例えば\nを用いると改行ができる。

print('Name: Anna\nFrom: Tokyo\nSchool: Stanford') Name: Anna From: Tokyo School: Stanfordprint()を用いて文字列を打つときに、""のなかに文字を入れるのだがその中に""が入っていたら、それを出力するとエラーが発生してしまう。それを防ぐためには、\を用いるか''を使って器用にこなすかである。

print(""I like Pizza!", but,"I don't like Sushi"") #実行結果 print(""I like Pizza!", but,"I don't like Sushi"") ^ SyntaxError: invalid syntax print("\"I like Pizza!\", but,\"I don't like Sushi\"") #実行結果 "I like Pizza!", but,"I don't like Sushi"このようにして利用すると簡易的にコメントのような文字が打てる。

'+'による連結

print('I' + 'am' + 'Chicken') #実行結果 IamChicken'*'による繰り返し

print('Hi '*10) #実行結果 Hi Hi Hi Hi Hi Hi Hi Hi Hi Hi'[]'による文字の抽出

ここでは対話型インタープリタ(ターミナル)を用いて実行していこう。

letters = 'abcdefghijklmnopqrstuvwxyz' letters[0] # 実行結果 'a'文字列はイミュータブル(変更できない)ので変更するにはreplace()を用いることで実行できる。しかしこれは一時的なものなのでその新しく変えたものを新しく変数として考えていく必要がある。またスライスというものを用いることも可能である。

new_letters = letters.replace('a', 'b') print(new_letters) bbcdefghijklmnopqrstuvwxyz print(letters) abcdefghijklmnopqrstuvwxyz new_letters_2 = 'n' + [1:] print(new_letters_2) nbcdefghijklmnopqrstuvwxyzスライスについてスライスは文字列から部分的な文字列を取り出すことができる。

*[:] 先頭から最後まで

*[X:]Xから最後まで

*[:X]最初からXまで

*[X:Y]XからYまで

*[X:Y:N]XからYまでをN文字ずつ順に取り出す。letters = 'abcdefghijklmnopqrstuvwxyz' print(letters[:]) print(letters[3:]) print(letters[:3]) print(letters[3:7]) print(letters[1:20:3]) abcdefghijklmnopqrstuvwxyz defghijklmnopqrstuvwxyz abc defg behknqtそのほかの関数:len(),split(),join()

len():文字列の文字数を確認するものだ。

split():分割(リストを作成)

join():結合(リストから文字列を作成)

これらについてコードから詳しく考えてみよう。len(letters) #実行結果 26 complex_letters = 'abc,def,ghi,jkl,mno,pqr,stu,vwx,yz' simple_letters_with_list = complex_letters.split(',') print(simple_letters_with_list) #実行結果 ['abc', 'def', 'ghi', 'jkl', 'mno', 'pqr', 'stu', 'vwx', 'yz'] new_complex_letters = ', '.join(simple_letters_with_list) print(new_complex_letters) abc, def, ghi, jkl, mno, pqr, stu, vwx, yz文字列の区別と配置

これに関してはコードのみで説明する。

letters_capi = letters.capitalize() #最初だけ大文字 print(letters_capi) 'Abcdefghijklmnopqrstuvwxyz' Greeting_patterns = 'hello, whats up!, wow' Title_Greeting_patterns = Greeting_patterns.title() #各文の最初の文字列を大文字にする。 print(Title_Greeting_patterns) 'Hello, Whats up!, Wow' Upper_Greeting_patterns = Greeting_patterns.upper() print(Upper_Greeting_patterns) #全て大文字にする。 'HELLO, WHATS UP, WOW' Lower_Greeting_patterns = Greeting_patterns.lower() #全て小文字にする 'hello, whats up!, wow' Greeting_patterns_center = Greeting_patterns.center(30) print(Greeting_patterns_center) #指定した数ないで文字を中心に寄せてくれる。 hello, what's up!, wow #左寄せ Greeting_patterns_left = Greeting_patterns.ljust(30) #右寄せ Greeting_patterns_right = Greeting_patterns.rjust(30) print(Greeting_patterns_left) hello, what's up!, wow print(Greeting_patterns_right) hello, what's up!, wow

- 投稿日:2021-02-25T20:27:49+09:00

毎朝LINEで天気を教えてくれるbotを作成した

はじめに

何番煎じだよ、と突っ込まれそうですが、毎朝LINEで天気をお知らせしてくれるbotを作成したいと思います。

BeautifulSoupの使い方とAPIの使い方が学べるので、Pythonが少しわかる程度にはもってこいの教材なんです。

独学なのでコードが汚いのはご了承を...。コード作成

まずはライブラリをインポートします。

BeautifulSoupはHTMLやXMLを解析するためのライブラリです。

データを取ってくるライブラリではないことに注意です。

データを取ってくるのにはrequestsというライブラリが必要です。必要なライブラリのインポートimport requests from bs4 import BeautifulSoup import datetime import schedule import time続いてBeautifulSoupオブジェクトを作成します。

今回スクレイプするサイトはtenki.jpです。

好きな市町村のURLを埋め込んでいただければ大丈夫です。

今回は例として福井市で設定します。

まず初めにhtmlにアクセスし、返された内容をBeautifulSoupの第一引数としてBeautifulSoupオブジェクトを作成します。

第二引数の"html.parser"はhtmlを解析する場合に選択するモードです。

以上の作業は基本的に同じなので、どのサイトにも同じことが書いてあると思います。BeautifulSoupオブジェクトの作成info = requests.get("https://tenki.jp/forecast/4/21/5710/18201/") # 好きな市町村のURLにしてもよいです bs = BeautifulSoup(info.content, "html.parser")取りたい情報の抽出を行います。

BeautifulSoupオブジェクトのfindメソッドを呼ぶと、子クラスのBeautifulSoupオブジェクトが返され、さらにfindメソッドを呼ぶことができます。

そのようにして階層的に目的の場所までたどり着きます。

今回はclassで指定しましたが、class名が同じタグもあるので、idで指定する方法の方が確実にたどり着けるかもです。

.stringでタグの中身を文字列として受け取れます。

今回は天気と最高気温と最低気温のみとしました。

私はそれだけで十分だったので...笑抽出today = bs.find(class_="today-weather") weather = today.find(class_="weather-telop").string high_temp = today.find_all(class_="value")[0].string low_temp = today.find_all(class_="value")[1].string message = "今日の天気は" + weather + "、最高気温は{}℃".format(high_temp) + "、最低気温は{}℃です。".format(low_temp) message'今日の天気は曇、最高気温は10℃、最低気温は-1℃です。'いい感じです!出来上がったメッセージをLINEで送信してみましょう。

"MY TOKEN"にあなたのLINENotifyトークンを入れればよいです。

LINENotifyトークンの取得およびメッセージ送信については、@moriita様の記事を参考にしてください。メッセージの送信headers = {"Authorization": "Bearer " + "MY TOKEN"} payload = {"message": message} r = requests.post("https://notify-api.line.me/api/notify", headers=headers, params=payload,)無事送信完了です。コードからメッセージを送れるとわくわくしますね。

さらに毎朝7時に定期実行をしたいと思います。定期実行を行うにはscheduleモジュールを活用します。

一日単位で指定の時刻で実行したいときは以下のようにします。schedule.every().day.at("時刻").do(起動したい関数f)このように設定しておくと、run_pendingメソッドが呼び出され時刻が条件を満たしている場合関数fが実行されます。

つまり、定期的(60s単位)にrun_pendingメソッドを呼び出す必要があります。定期実行の設定schedule.every().day.at("7:00").do(send) while True: schedule.run_pending() time.sleep(10) print("Running...")以上がコードの基盤です。これを組み合わせてコーディングしていきましょう。

完成コード

weather_notify.pyimport requests from bs4 import BeautifulSoup import datetime import schedule import time class Weather: def __init__(self, weather_url, token, time): self.weather_url = weather_url self.line_url = "https://notify-api.line.me/api/notify" self.token = token self.time = time def parse_make_message(self): info = requests.get(self.weather_url) bs = BeautifulSoup(info.content, "html.parser") today = bs.find(class_="today-weather") weather = today.find(class_="weather-telop").string high_temp = today.find_all(class_="value")[0].string low_temp = today.find_all(class_="value")[1].string message = "今日の天気は" + weather + "、最高気温は{}℃".format(high_temp) + "、最低気温は{}℃です。".format(low_temp) return message def send(self): headers = {"Authorization": "Bearer " + self.token} payload = {"message": self.parse_make_message()} r = requests.post(self.line_url, headers=headers, params=payload,) def set_do(self): schedule.every().day.at(self.time).do(self.send) while True: schedule.run_pending() time.sleep(10) print("Running...") fukui_url = "https://tenki.jp/forecast/4/21/5710/18201/" my_token = "MY TOKEN" weather = Weather(weather_url=fukui_url, token=my_token, time="07:00") weather.set_do()おわりに

たった数行で毎朝を便利にしてくれるのでよいプロダクトではないでしょうか。

問題点としてはずっとプログラムを実行させる必要があるところです。

windowsの定期実行を利用してpythonファイルを開く方がよさそうですね...。

改良版お待ちください...。

- 投稿日:2021-02-25T20:23:03+09:00

nginx・gunicorn・djangoの環境におけるTips

webアプリケーションを開発したものの、インフラ周りが弱いため、Tipsとしてまとめていくつもりです。

適宜、更新はしていくつもりです。間違いだった場合は指摘いただければ幸いです。クラウドには、digital oceanを使用しています。

基本的には、現場で使える Django の教科書《実践編》を模倣しています。

アーキテクチャはこちらから技術スタック

- Django(3.0.8)

- nginx(1.18.0)

- gunicorn(20.0.4)

- ubuntu(20.04)

ファイル構成

/home/webapp/mysite/[django-project]

変更を反映させたい時

nginx、gunicorn、djangoなど色々いじると思います。

開発環境とは異なり、いじったらrestartしないといけないです。gunicorn周りを変更した時

反映させるファイルは、

/etc/systemd/system/mysite.serviceと/etc/systemd/system/mysite.socketです。特に、daemon-reloadも必要らしい。ということで、

sudo systemctl daemon-reload

(↑sudoをつけないと怒られた)

sudo systemctl restart mysite.service

sudo systemcctl restart mysite.socketdjangoの中身(models.pyとかviews.pyとか)を変更したとき

なぜかわかりませんが、ここら辺の変更を適用するためには

sudo systemctl restart mysite.service

が必要でした。もちろん、models.py周りを変更した際は

python manage.py makemigrationsやpython manage.py migrateも忘れずに。nginx周りを変更させたとき

restartをしましよう。

sudo systemctl restart nginx状態を知りたいとき

基本的には、

sudo systemctl statusでOKでした。ex.

sudo systemctl status nginx

sudo systemctl status mysite.service

sudo systemctl status mysite.socket後は、

error_logですね。

/var/log/nginx/error_logです。最終更新日

- 2020.02.25

- 投稿日:2021-02-25T20:06:58+09:00

GCPロギングを使いPython(Flask)のログを管理

GCPロギングを使いPython(Flask)のログを管理

google-cloud-logging をインストール

$ pip install google-cloud-loggingロギング設定

from google.cloud import logging client = logging.Client() logger = client.logger("pronichi")ログ用の関数

severityはログレベル(INFO,NOTICE,ERROR etc...)

ログは環境変数、URI、任意メッセージを保存することにした

ensure_ascii=Falseを設定しないとコンソール表示が文字化けdef log_write(severity: str, uri: str, message: str): tmp = {"env": APP_ENV, "uri": uri, "message": message} tmp_json = json.dumps(tmp, ensure_ascii=False) logger.log_text(tmp_json, severity=severity)スクリプトにログ追加

log_write("NOTICE", "/", "テスト")ログ確認

{ textPayload: "{"env": "prod", "uri": "/", "message": "テスト"}" insertId: "1io3pqvgej50y6v" resource: {2} timestamp: "2021-02-24T16:15:50.363645648Z" severity: "NOTICE" logName: "projects/weekend-hackathon/logs/pronichi" receiveTimestamp: "2021-02-24T16:15:50.363645648Z" }

ログが出力できるようになりました

いいね!と思ったら LGTM お願いします【PR】プログラミング新聞リリースしました! → https://pronichi.com

【PR】週末ハッカソンというイベントやってます! → https://weekend-hackathon.toyscreation.jp/about/

- 投稿日:2021-02-25T19:40:00+09:00

Pythonチュートリアル ノート

概要

Pythonチュートリアルを読みながら手元で実行したコマンドのメモ。

https://docs.python.org/ja/3/tutorial/index.html1. やる気を高めよう

Pythonの特徴

- インタプリタ言語なので、コンパイル・リンクが不要。電卓として使える。

- シェルはファイル操作・テキストデータの操作に向いているけど、GUIアプリ、ゲームには向いていない。単純にシェルより機能が多い。

- GUIのインターフェイスも標準で提供される。(Tk)

- テキスト処理ならAwkとかPerlもあるが、それらより汎用的なデータ型が存在する。それでいて同じくらい簡単。

- C, Javaよりコードが短くなる。より高レベルなデータ型があるのと、実行文のグループ化がインデントなので、括弧だけの行がない。

- Cアプリケーションの拡張言語として利用可能。

- 変数、引数宣言が不要

- モンティパイソンの空飛ぶサーカス「Monty Python's Flying Circus」が元ネタ。

2. Python インタプリタを使う

コマンドを指定したインタプリタの起動

python -c command [arg] ... python3 -c "print(1 + 2)"スクリプト実行後にそのまま対話モードに入れる。-iオプション

# 2-1.py a = 12 $ python3 -i 2-1.py >>> a 12 >>>コマンドライン引数

sysモジュールのargv変数に格納される。

# 2-2.py import sys print(sys.argv) $ python3 2-2.py ['2-2.py'] $ python3 2-2.py asdf ['2-2.py', 'asdf']sys[0]はスクリプトならファイル名、コマンド指定でインタプリタを起動した場合は"-c"

python3 -c "import sys; print(sys.argv)" ['-c']文字コードを指定するにはファイルの先頭にエンコーディングを記述する。

# -*- coding:cp1242 -*-3. 形式ばらない Python の紹介

除算と整数除算

python3から除算と整数除算の演算子が分かれて定義された。

>>> 17 / 3 5.666666666666667 >>> 17 // 3 5冪乗

>>> 2**10 1024対話モードで便利な「_」

対話モードでのみ、前回の計算結果が「_」に毎回代入される。_

>>> 60 * 60 3600 >>> 24 * _ 86400文字列リテラル

# 3-1.py a = """ hello world """ $ python3 -i 3-1.py >>> a '\n\n hello\n\n world\n\n\n' >>>スライス

スライスの場合のみ範囲外のインデックスでもエラーにならない。

>>> a = "abcdefg" >>> a[3:] 'defg' >>> a[-2] 'f' >>> a[2] 'c' >>> a[2:-2] 'cde' >>> a[100] Traceback (most recent call last): File "<stdin>", line 1, in <module> IndexError: string index out of range >>> a[2:100] 'cdefg'リスト

リストの代入は参照が返るので、破壊的な操作が起き得る。

>>> a = [1,2,3] >>> b = a >>> b [1, 2, 3] >>> b[0] = 100 >>> b [100, 2, 3] >>> a [100, 2, 3] >>>[https://docs.python.org/ja/3/library/copy.html#shallow-vs-deep-copy]

浅いコピーで回避可能。

スライスか、copyモジュールのcopy関数で浅いコピーを作れる。>>> import copy as cp >>> a = [1,2,3] >>> b = cp.copy(a) >>> b [1, 2, 3] >>> b[0] = 100 >>> a [1, 2, 3] >>> b [100, 2, 3]浅いコピーは1次元のリストのみ有効。

>>> a = [[1,2], [2,3], [3,4]] >>> b = a[:] >>> b [[1, 2], [2, 3], [3, 4]] >>> b[0][0] = 100 >>> b [[100, 2], [2, 3], [3, 4]] >>> a [[100, 2], [2, 3], [3, 4]] >>>2次元以上のリストをコピーする場合、深いコピーが必要。

copyモジュールのdeepcopy関数で深いコピーが作れる。>>> import copy as cp >>> a = [[1,2],[2,3],[3,4]] >>> b = cp.deepcopy(a) >>> b[0][0] = 100 >>> b [[100, 2], [2, 3], [3, 4]] >>> a [[1, 2], [2, 3], [3, 4]] >>>リストのスライス代入

スライス代入によりサイズの変更、削除が自由。

>>> a = [0,1,2,3,4,5,6,7,8,9] a[2:4] = [] >>> a [0, 1, 4, 5, 6, 7, 8, 9]複数同時代入

スワップにも利用可能

>>> a, b = 1,2 >>> a 1 >>> b 2 >>> a, b = b, a >>> a 2 >>> b 14. その他の制御フローツール

elif

else ifをelifと省略して書ける。switch文が無いので代わりに使う。

for

C言語のforみたいなのは無くて、foreachのようなforがある。

>>> for a in [1,2,3]: ... print(a) ... 1 2 3for (int i = 0; i < 10; i++)

は以下のようにrangeを使う。>>> for i in range(10): ... print(i) ... 0 1 2 3 4 5 6 7 8 9ちなみに、rangeの戻り値がリストになっているかというとそうではない。

rangeクラスのオブジェクトが返る。>>> print( type([0,1,2]) ) <class 'list'> >>> print( type(range(3)) ) <class 'range'>[https://docs.python.org/ja/3/tutorial/controlflow.html]

range() が返すオブジェクトは、いろいろな点でリストであるかのように振る舞いますが、本当はリストではありません。これは、イテレートした時に望んだ数列の連続した要素を返すオブジェクトです。しかし実際にリストを作るわけではないので、スペースの節約になります。

こういうオブジェクトはイテラブル(iterable: 反復可能)と呼ばれる。

sum()はイテラブルも受け取れるようになっている。(リストも受け取れる)>>> sum(range(10)) 45 >>> sum([0,1,2,3,4,5,6,7,8,9]) 45イテラブルからリストへの変換

>>> list(range(10)) [0, 1, 2, 3, 4, 5, 6, 7, 8, 9]for文はelse節も持てる。

>>> for i in range(3): ... print(i) ... else: ... print("test") ... 0 1 2 testfor文のelse句は途中でbreakされると呼ばれない。

>>> for i in range(3): ... if i > 1: ... break ... print(i) ... else: ... print("test") ... 0 1pass

pythonはブロックの中を省略できないので、そういう場合はpass文を書いておく。

pass文は何もしない。>>> a = 1 >>> if a > 0: ... File "<stdin>", line 2 ^ IndentationError: expected an indented block >>> >>> if a > 0: ... pass ... >>> >>>関数

def fib(n): """docstringをここに書く""" a, b = 0, 1 for i in range(n): a, b = b, a + b return bNone

return文の無い関数はNoneを返す。意味がないのでインタプリタは通常出力を抑制する。

def test(): pass >>> test() >>> print(test()) None >>> type(test()) <class 'NoneType'>シンボルテーブル

pythonにはブロックスコープがあり、例えば関数内から変数を参照した際には、まず関数内のシンボルテーブルから変数が参照され、次により外側のローカルなシンボルテーブルが参照され、、と続いていく。

ローカルなシンボルテーブルはlocals()で確認可能。>>> def test(): ... aaa = 1 ... for item in locals().items(): ... print(item[0]) ... >>> >>> test() aaa >>>デフォルト引数

>>> def test(a = 50): ... print(a) ... >>> test() 50 >>> test(2) 2デフォルト値は最初の一度しか評価されない。

最初の呼び出しでarrが初期化され、それ以降は同じオブジェクトが使い回されるので注意。>>> def test(arr = []): ... arr.append("aaa") ... return arr ... >>> >>> test() ['aaa'] >>> test() ['aaa', 'aaa'] >>> test() ['aaa', 'aaa', 'aaa']キーワード引数

引数名を指定することで、順番を気にせず引数を渡すことが可能

>>> def test(a = 1, b = 2): ... print(a, b) ... >>> test() 1 2 >>> test(b = 5) 1 5*name形式の仮引数があると、タプル型として扱われて実引数の値がそこに入る。

>>> def test(*a): ... print(type(a), a) ... >>> test() <class 'tuple'> () >>> >>> test(1, 2, 3) <class 'tuple'> (1, 2, 3) >>> >>> test(1, 2, 3, a = 1) Traceback (most recent call last): File "<stdin>", line 1, in <module> TypeError: test() got an unexpected keyword argument 'a' >>> >>>**name形式の仮引数は辞書型として扱われて、実引数のkey, valueが入る。

>>> def test(**a): ... print(type(a), a) ... >>> test() <class 'dict'> {} >>> >>> test(b = 1, c = 2) <class 'dict'> {'b': 1, 'c': 2} >>> >>> >>> test(1) Traceback (most recent call last): File "<stdin>", line 1, in <module> TypeError: test() takes 0 positional arguments but 1 was given >>>*name形式、**name形式は混在可能。

>>> def test(*a, **b): ... print(type(a), a, type(b), b) ... >>> test() <class 'tuple'> () <class 'dict'> {} >>> >>> test(1,2,3) <class 'tuple'> (1, 2, 3) <class 'dict'> {} >>> >>> test(a = 1) <class 'tuple'> () <class 'dict'> {'a': 1} >>> >>> test(1,2,3,a = 1) <class 'tuple'> (1, 2, 3) <class 'dict'> {'a': 1} >>>特殊な仮引数「/」「*」

def test(a, /, b, *, c):とした場合、

a: 第一引数としてのみ渡せる。(位置専用引数)

b: 第二引数として渡すか、キーワード引数として渡す。

c: キーワード引数としてのみ渡せる。(キーワード専用引数)

という意味になる。>>> def test(a, /, b, *, c): ... print(a, b, c) ... >>> test(1, 2, 3) Traceback (most recent call last): File "<stdin>", line 1, in <module> TypeError: test() takes 2 positional arguments but 3 were given >>> >>> test(1, 2, c = 3) 1 2 3 >>> >>> test(1, c = 3, b = 2) 1 2 3 >>> >>> test(c = 3, b = 2, a = 1) Traceback (most recent call last): File "<stdin>", line 1, in <module> TypeError: test() got some positional-only arguments passed as keyword arguments: 'a'以下のように、キーワード専用のみの引数も定義可能

>>> def test(*, a): ... print(a) ... >>> test() Traceback (most recent call last): File "<stdin>", line 1, in <module> TypeError: test() missing 1 required keyword-only argument: 'a' >>> >>> test(1) Traceback (most recent call last): File "<stdin>", line 1, in <module> TypeError: test() takes 0 positional arguments but 1 was given >>> >>> test(a = 1) 1 >>>任意引数リスト

必須パラメータと任意パラメータを以下のように組み合わせることがある。

複数の引数を入力した場合は、paramsにタプル型として渡される。>>> def test(a, *params): ... print(a, params) ... >>> test() Traceback (most recent call last): File "<stdin>", line 1, in <module> TypeError: test() missing 1 required positional argument: 'a' >>> test(1) 1 () >>> test(1, 2) 1 (2,) >>> test(1, 2, 3) 1 (2, 3) >>>任意引数リストの後に定義した仮引数はキーワード専用変数になる。

>>> def test(*params, a): ... print(params, a) ... >>> test() Traceback (most recent call last): File "<stdin>", line 1, in <module> TypeError: test() missing 1 required keyword-only argument: 'a' >>> test(1) Traceback (most recent call last): File "<stdin>", line 1, in <module> TypeError: test() missing 1 required keyword-only argument: 'a' >>> test(a = 0) () 0 >>> test(1, a = 0) (1,) 0 >>> test(1, 2, a = 0) (1, 2) 0アンパック

リストをアンパックすることにより、要素を引数として利用可能

>>> def test(a, b, c): ... print(a, b, c) ... >>> l = [1, 2, 3] >>> test(l) Traceback (most recent call last): File "<stdin>", line 1, in <module> TypeError: test() missing 2 required positional arguments: 'b' and 'c' >>> >>> test(*l) 1 2 3 >>>辞書もアンパックすることでキーワード引数として利用可能

>>> def test(a, b, c): ... print(a, b, c) ... >>> d = {"a": 10, "b": 20, "c": 30} >>> >>> test(d) Traceback (most recent call last): File "<stdin>", line 1, in <module> TypeError: test() missing 2 required positional arguments: 'b' and 'c' >>> >>> >>> test(**d) 10 20 30引数まとめ

- 引数の名前を知らせる必要がないなら位置専用引数を使う。

- 引数の名前に意味があるなら順番を覚える必要のないキーワード引数が便利。

- APIでは名前を変更した際に動かなくなると困るので位置専用引数を使う。

ラムダ式

>>> a = lambda n: n + 1 >>> a <function <lambda> at 0x104fc3af0> >>> a(1) 2 >>>ドキュメンテーション文字列

>>> def test(n): ... """1行目は簡潔にまとめた説明を書く。 ... ... 2行目は空けて、3行目から呼び出しの規約、副作用について書く。 ... """ ... return n + 1 ... >>> test(1) 2 >>> test.__doc__ '1行目は簡潔にまとめた説明を書く。\n\n\t2行目は空けて、3行目から呼び出しの規約、副作用について書く。\n\t' >>>アノテーション

ドキュメントとして戻り値の型を知らせることが可能。動作には影響しない。

>>> def test()->str: ... print("test") ... >>> test.__annotations__ {'return': <class 'str'>}コーディング規約

基本PEP8に従う。PEPは海外でも「ペップ」と読まれているらしい。

[https://pep8-ja.readthedocs.io/ja/latest/]5. データ構造

List

初期化

>>> a = [] >>> type(a) <class 'list'>要素の追加: append(x)

マージはされない。

>>> a = [] >>> a.append(1) >>> a [1] >>> a.append([2,3,4]) >>> a [1, [2, 3, 4]]要素の拡張: extend(iterable)

>>> a [1, 2, 3] >>> a.extend([4,5,6]) >>> a [1, 2, 3, 4, 5, 6] >>>要素の挿入: insert(i, x)

>>> a = [5, 6, 7] >>> a.insert(2, 100) >>> a [5, 6, 100, 7] >>>要素の削除: remove(x)

値で検索して最初の要素を削除

>>> a = [100, 200, 300] >>> a.remove(200) >>> a [100, 300] >>>要素の取り出し: pop([i])

指定しなければ末尾、指定されればそのインデックスの要素を取り出す。

>>> a = [100, 200, 300, 400] >>> a.pop() 400 >>> a [100, 200, 300] >>> a.pop(1) 200 >>> a [100, 300]要素の全削除: clear()

>>> a = [1, 2, 3, 4, 5] >>> a.clear() >>> a [] >>>要素の検索: index(x, [start, end])

>>> a = [1, 3, 5, 7, 9] >>> a.index(5) 2 >>> a.index(5, 0, 4) 2 >>> a.index(5, 0, 3) 2 >>> a.index(5, 0, 2) Traceback (most recent call last): File "<stdin>", line 1, in <module> ValueError: 5 is not in list >>> >>> a.index(5, 1, 4) 2 >>> a.index(5, 2, 4) 2 >>> a.index(5, 3, 4) Traceback (most recent call last): File "<stdin>", line 1, in <module> ValueError: 5 is not in list要素のカウント: count

>>> a [5, 6, 6, 7, 7, 7, 8] >>> >>> a.count(6) 2 >>> a.count(7) 3 >>>ソート

>>> a [4, 2, 6, 6, 5, 4] >>> a.sort() >>> a [2, 4, 4, 5, 6, 6] >>> a.sort(reverse=True) >>> a [6, 6, 5, 4, 4, 2]キーによるソート

>>> a [(5, 'asdf'), (2, 'zxcv'), (8, 'bbb')] >>> a.sort(key = lambda tpl: tpl[1]) >>> a [(5, 'asdf'), (8, 'bbb'), (2, 'zxcv')]逆順ソート

>>> a [6, 6, 5, 4, 4, 2] >>> a.sort() >>> a [2, 4, 4, 5, 6, 6] >>> a.reverse() >>> >>> a [6, 6, 5, 4, 4, 2]配列のコピー(shallow)

>>> b = a.copy() >>> b [1, 2, 3] >>> b[0] = 100 >>> b [100, 2, 3] >>> a [1, 2, 3] >>>スタック

>>> a = [1,2,3] >>> a.pop() 3 >>> a [1, 2] >>>キュー

リストの終端に対する操作は速いが、先頭に対しての操作は遅い。

例えば、先頭から1つ取り出すと、要素を全てずらす必要がある。

キューを利用したい場合、リストではなくキューの操作に最適化されたdequeを利用するのがよい。double-ended queue (両端キュー)

>>> a = deque([1,2,3]) >>> a deque([1, 2, 3]) >>> a.popleft() 1 >>> a.popleft() 2 >>> a deque([3]) >>> a.append(5) >>> a deque([3, 5])リスト内包表記

>>> a = [ i * 2 for i in range(10) ] >>> a [0, 2, 4, 6, 8, 10, 12, 14, 16, 18]2重ループ

>>> [(i,j) for i in range(3) for j in range(3)] [(0, 0), (0, 1), (0, 2), (1, 0), (1, 1), (1, 2), (2, 0), (2, 1), (2, 2)]del

関数ではなく文である理由:

>>> a = [1,2,3] >>> a [1, 2, 3] >>> del a[0] >>> a [2, 3]タプル

>>> a = 1,2,3 >>> a (1, 2, 3) >>> type(a) <class 'tuple'> >>> a[2] 3 >>> a = (1,2,3) >>> a (1, 2, 3) >>> type(a) <class 'tuple'> >>> a = () >>> a () >>> type(a) <class 'tuple'> >>> >>> a = 1, >>> a (1,) >>> type(a) <class 'tuple'> >>> >>> len(a) 1集合

宣言

>>> a = {1,2,3} >>> type(a) <class 'set'> >>> >>> >>> a = {} >>> type(a) <class 'dict'> >>>演算

>>> a = {1,2,3,4,5} >>> b = {4,5,6,7,8} >>> a + b Traceback (most recent call last): File "<stdin>", line 1, in <module> TypeError: unsupported operand type(s) for +: 'set' and 'set' >>> >>> >>> >>> a - b {1, 2, 3} >>> a | b {1, 2, 3, 4, 5, 6, 7, 8} >>> a &b {4, 5} >>> >>> >>> a ^ b {1, 2, 3, 6, 7, 8} >>>辞書

マップ、連想配列、と同じもの。

>>> a = {'aaa': 10, 'bbb': 20} >>> a {'aaa': 10, 'bbb': 20} >>> a['aaa'] 10items()メソッドにより、key, value両方が取り出せる。

dict_items型として取り出しているらしい。>>> for i in a: ... print(i, a[i]) ... aaa 10 bbb 20 >>> >>> >>> for k, v in a.items(): ... print(k, v) ... aaa 10 bbb 20 >>> a.items() dict_items([('aaa', 10), ('bbb', 20)]) >>> type(a.items()) <class 'dict_items'> >>>zip

>>> for i, j in zip(a, b): ... print(i, j) ... 1 4 2 5 3 6配列の要素をユニークに

>>> a = [1, 2, 2, 3, 3, 4] >>> a [1, 2, 2, 3, 3, 4] >>> set(a) {1, 2, 3, 4} >>>in

要素が存在するか調べる。

>>> a [1, 2, 2, 3, 3, 4] >>> 3 in a True >>> 5 in a Falseセイウチ演算子

「:=」のこと。式中での代入に使う。

>>> f = open("aaa") >>> while line := f.readline(): ... line ... 'aaa\n' 'bbb\n' 'ccc\n' >>> while line = f.readline(): File "<stdin>", line 1 while line = f.readline(): ^ SyntaxError: invalid syntax >>>シーケンスオブジェクト同士の比較

辞書順で先頭から比較していく。

>>> [1,2,3,4,5] < [1,2,4,5,6] True6. モジュール

モジュールの作成

処理をファイルに分割して記述し、別の場所からファイル名 = モジュール名としてimport可能。

$ cat test.py def aaa(): print("test func is called.") >>> import test >>> dir(test) ['__builtins__', '__cached__', '__doc__', '__file__', '__loader__', '__name__', '__package__', '__spec__', 'aaa'] >>> test.aaa() test func is called. >>>モジュールの定義を全てimport

読み込み元の名前空間にシンボルが上書きされるので、確認用途以外では使わない。

$ cat aaa.py def asdf(): print("asdf") def zxcv(): print("zxcv") def qwer(): print("qwer") >>> from aaa import * >>> globals() {'__name__': '__main__', '__doc__': None, '__package__': None, '__loader__': <class '_frozen_importlib.BuiltinImporter'>, '__spec__': None, '__annotations__': {}, '__builtins__': <module 'builtins' (built-in)>, 'asdf': <function asdf at 0x1015f2d30>, 'zxcv': <function zxcv at 0x1015f2ee0>, 'qwer': <function qwer at 0x1015f2f70>}名前付きでimport

>>> import test as zzzzz >>> zzzzz.aaa() test func is called.モジュールの初期実行

モジュール読み込み時に一度モジュールの中身が実行される。

通常、これを初期化に利用する。$ cat bbb.py print("bbb.py is loaded.") def test(): print("test is called.") >>> import bbb bbb.py is loaded. >>> bbb.test() test is called. >>>コマンドラインから実行した場合の処理

コマンドラインからスクリプトを実行すると、モジュールの「__name__」が「__main__」になる。

$ cat ccc.py cat ccc.py def test(): print("test is called.") print(__name__) >>> import ccc ccc >>> $ python ccc.py __main__これを利用し、コマンドライン実行の場合のみ実行される処理が定義可能。

$ cat ccc.py f = False def action(): print("Initialized." if f else "Not initialized.") if __name__ == "__main__": f = True action() $ python ccc.py Initialized. >>> import ccc >>> ccc.action() Not initialized. >>>モジュールの検索パス

モジュールは以下のパスから検索される。

- ビルトインモジュール

- 実行対象のスクリプトのディレクトリ

- カレントディレクトリ

- PYTHONPATH

モジュールのコンパイル

モジュールの読み込みを高速化するため、コンパイルされているファイルが存在しない場合、読み込み時にモジュールはコンパイルされ、「__pycache__」ディレクトリに出力される。

ls __pycache__ aaa.cpython-39.pyc ccc.cpython-39.pyc test.cpython-39.pyc bbb.cpython-39.pyc fibo.cpython-39.pyc標準モジュール

いくつかのモジュールはインタプリタにビルトインされている。

例えば、sysモジュール等。dir()

引数無し実行。

locals()で得られるリストと同様の模様。>>> dir() ['__annotations__', '__builtins__', '__doc__', '__loader__', '__name__', '__package__', '__spec__', 'a'] >>> sorted(list(locals().keys())) ['__annotations__', '__builtins__', '__doc__', '__loader__', '__name__', '__package__', '__spec__', 'a']モジュール内の変数、関数などのリスト取得

>>> import aaa >>> dir(aaa) ['__builtins__', '__cached__', '__doc__', '__file__', '__loader__', '__name__', '__package__', '__spec__', 'asdf', 'qwer', 'zxcv']パッケージ

「__init__.py」が存在するとパッケージとして認識される。

>>> import p.a.aaa p.__init__ is loaded. a.__init__ is loaded. aaa.py is loaded. >>> >>> p.a.aaa.test() aaa.test() is called. >>>読み込まれるモジュールの指定

「__init__.py」内の「__all__」にデフォルトで読み込むモジュールを指定可能

$ ls __init__.py asdf.py qwer.py zxcv.py $ cat __init__.py print("b.__init__ is called.") __all__ = ["qwer", "zxcv"] >>> from p.b import * p.__init__ is loaded. b.__init__ is called. qwer is loaded zxcv is loaded同パッケージ内でのモジュール読み込み

同じパッケージに属するモジュールを読み込む際、

- 絶対パスでimport

- 相対パスでimport

の2パターン存在する。

絶対パスでimportする場合

$ cat p/b/test.py import p.a.aaa def f(): p.a.aaa.test() >>> import p.b.test p.__init__ is loaded. b.__init__ is called. a.__init__ is loaded. aaa.py is loaded. >>> >>> p.b.test.f() aaa.test() is called. >>>相対パスでimportする場合

cat test.py from ..a import aaa def f(): aaa.test() >>> import p.b.test p.__init__ is loaded. b.__init__ is called. a.__init__ is loaded. aaa.py is loaded. >>> >>> p.b.test.f() aaa.test() is called. >>>7. 入力と出力

変数展開

>>> v = 100 >>> s = f'v: {v}' >>> >>> s 'v: 100' >>> >>> f'pi: {math.pi:.3f}' 'pi: 3.142' >>>formatメソッド

>>> import math >>> '{:1.5}'.format(math.pi) '3.1416' >>> '{:1.7}'.format(math.pi) '3.141593'repr()とstr()

reprはデバッグ用途。

>>> str(datetime.date.today()) '2021-02-10' >>> >>> repr(datetime.date.today()) 'datetime.date(2021, 2, 10)' >>>str.format()とvars()の組み合わせ

vars()はローカルな変数の一覧を返す。

以下のように利用すると、format()の引数を入力する手間が省けてデバッグ時に便利。>>> format = 'a = {a}, v = {v}' >>> a = 5 >>> v = 10 >>> >>> fmt.format(**vars()) 'a = 5, v = 10'出力文字列のセンタリング

右寄せはrjust(10), 左寄せはrjust(10)。

引数10は桁数。>>> for i in range(10): ... print(repr(i**5).center(10)) ... 0 1 32 243 1024 3125 7776 16807 32768 59049ゼロ埋め

>>> '5'.zfill(5) '00005'古いフォーマット指定

>>> 'pi: %.3f' % math.pi 'pi: 3.142'ファイル書き込み・読み込み

>>> f = open("a", "w") >>> f.write("hello world.") 12 >>> f.close() >>> >>> >>> f = open("a") >>> f.readline() 'hello world.' >>> >>> f.seek(0) 0 >>> f.readline() 'hello world.' >>>with文によるclose()の省略

>>> with open("a") as f: ... f.readline() ... 'hello world.' >>>読み込む文字数の指定

>>> with open("a") as f: ... f.read(1) ... 'h'1行ずつ高速に読み込む

$ cat aaa aaa bbb ccc >>> f = open("aaa") >>> for line in f: ... line ... 'aaa\n' 'bbb\n' 'ccc\n' >>>全ての行を一度に読み込む

readline()使用

>>> with open("aaa") as f: ... f.readlines() ... ['aaa\n', 'bbb\n', 'ccc\n'] >>>list()使用

>>> with open("aaa") as f: ... list(f) ... ['aaa\n', 'bbb\n', 'ccc\n']jsonの読み込み

$ cat a.json { "aaa": 5, "bbb": [1, 2, 3], "ccc": "test" } >>> with open("a.json") as f: ... json.load(f) ... {'aaa': 5, 'bbb': [1, 2, 3], 'ccc': 'test'}8. エラーと例外

構文エラー

SyntaxError: 構文エラー

>>> if aaa File "<stdin>", line 1 if aaa ^ SyntaxError: invalid syntax >>>例外のtry, catch

>>> try: ... aaa ... except NameError: ... print("Name Error occured.") ... Name Error occured.例外が起きなかった場合の処理 (try, else)

>>> try: ... True ... except NameError: ... print("name error.") ... else: ... print("no problem.") ... True no problem. >>>例外の送出 (raise)

raiseで送出できるのはExceptionクラスを継承した例外クラスのみ。

>>> try: ... raise Exception("aaa") ... except Exception as e: ... e ... type(e) ... e.args ... Exception('aaa') <class 'Exception'> ('aaa',) >>>raiseを再度実行することで、再送出可能

>>> try: ... raise Exception("aaa") ... except Exception as e: ... e ... raise ... Exception('aaa') Traceback (most recent call last): File "<stdin>", line 2, in <module> Exception: aaa例外の連鎖 (raise, from)

>>> try: ... raise IOError ... except Exception as e: ... raise RuntimeError from e ... Traceback (most recent call last): File "<stdin>", line 2, in <module> OSError The above exception was the direct cause of the following exception: Traceback (most recent call last): File "<stdin>", line 4, in <module> RuntimeError >>>例外クラスの自作

Exceptionから派生したクラスを作成可能

>>> class MyError(Exception): ... pass ... >>> >>> raise MyError("test") Traceback (most recent call last): File "<stdin>", line 1, in <module> __main__.MyError: test必ず実行されるクリーンアップ動作 (Finally節)

with文を利用したファイル操作等、問題発生時にファイルがcloseされるようにクリーンアップ動作が設定されているものがある。

例外処理の際、このようなクリーンアップ動作をFinally節により指定可能。>>> try: ... True ... except NameError: ... print("name error.") ... else: ... print("no problem") ... finally: ... print("done.") ... True no problem done. >>>9. クラス

- クラスはデータと機能を組み合わせる方法

- 他の言語より最小限の構文でクラスを作成できる

- オブジェクト指向プログラミングの標準的な機能を提供する。

- 複数の基底クラスを持つことが可能

- 基本的にクラスメンバはpublicで、virtual。よってオーバーライド可能。

- c++と異なり、組み込み型についても拡張可能。

nonlocal

Pythonでは、外側のスコープの変数は基本読み取り専用。

a()の中からvalの読み取りは可能。>>> def test(): ... def a(): ... print(val) ... val = 1 ... a() ... >>> test() 1しかし、val = 3と書き換えようとするとエラー。

>>> def test(): ... def a(): ... print(val) ... val = 3 ... val = 1 ... a() ... >>> test() Traceback (most recent call last): File "<stdin>", line 1, in <module> File "<stdin>", line 6, in test File "<stdin>", line 3, in a UnboundLocalError: local variable 'val' referenced before assignment >>>これに対し、nonlocal文を使うことで書き込みできるようになる。

def test(): def a(): nonlocal val print(val) val = 3 val = 1 a() >>> test() >>> 1global

ローカル変数のグローバルスコープへの束縛。

def test(): global a a = "asdf" test() aclass

クラス定義はif文内にも記述可能

>>> f = 1 >>> if f == 1: ... class A: ... pass ... else: ... class B: ... pass ... >>> A() <__main__.A object at 0x102fbdb20> >>> B() Traceback (most recent call last): File "<stdin>", line 1, in <module> NameError: name 'B' is not definedclass定義の終端を抜けるとクラスオブジェクトが生成される。

別の言語のような宣言ではなくクラスオブジェクトの生成であり、type型のインスタンスが作成される。>>> class A: ... pass ... >>> A <class '__main__.A'>属性参照

クラスのメンバ変数、メンバ関数のことを属性と呼んでいる。

属性には「.」でアクセスする。>>> class A: ... a = 1 ... def asdf(): ... print("asdf is called") ... >>> A.a 1 >>> A.asdf() asdf is calledクラスのインスタンス化

pythonにnew演算子は無く、クラスオブジェクトをcallすることでインスタンスが作成される。

>>> class A: ... pass ... >>> A() <__main__.A object at 0x1013129d0>init

クラスのインスタンス化時に「__init__」メソッドが呼ばれる。

通常、初期化はこの中で行う。>>> class A: ... def __init__(self): ... print("init is called.") ... >>> >>> A() init is called. <__main__.A object at 0x10149d430>メソッドオブジェクト

メソッドの第一引数にはインスタンスオブジェクトが渡される。

>>> class A: ... def test(self): ... print(self) ... >>> a = A() >>> a.test() <__main__.A object at 0x1013d4c40> >>> >>> A.test("aa") aa >>> A.test() Traceback (most recent call last): File "<stdin>", line 1, in <module> TypeError: test() missing 1 required positional argument: 'self' >>>インスタンスオブジェクトの変数名は別に「self」でなくてもよい。

が、ツール等でこの文字列を当てにしている場合があるので注意。>>> class A: ... def __init__(a): ... print(a) ... >>> a = A() <__main__.A object at 0x1013b9b50>メンバ変数

>>> class A: ... def __init__(self): ... self.val = "default" ... def set(self, val): ... self.val = val ... >>> a = A() >>> a.val 'default' >>> >>> a.set(10) >>> a.val 10 >>>メソッドが参照するスコープ

メソッド内から参照するスコープは基本グローバルスコープ。

データ属性を優先的に参照するなどは無い。>>> a = 1 >>> class A: ... a = 2 ... def f(self): ... print(a) ... print(self.a) >>> b = A() >>> b.f() 1 2プライベート変数について

クラスのメンバ(データ属性)はプライベートにできない。これはPythonにおいてクラスを純粋な抽象データ型として使うことができないことを意味する。

あらゆる属性をプライベートにできないので、クラスの利用者はいくらでも拡張してしまえる。そこで、Pythonではアンダースコア始まりのメンバをプライベートとして扱うことが慣習となっている。>>> class A: ... _val = 1 ... def f(self): ... print(self._val) ... >>> a = A() >>> a.f() 1 >>> >>> a._val 1 >>>あくまで慣習なので、上記の例のように「a._val」とアクセスできるが、推奨はされない。

ネームマングリング (name mangling)

アンダースコア2つで始まる属性はクラス名を頭に付けないと参照できなくなる。

これをネームマングリング機構と呼ぶ。

主に親クラスと名前が衝突しないようにするために利用される。>>> class A: ... __val = 1 ... def f(self): ... print(self.__val) ... >>> >>> a = A() >>> a.__val Traceback (most recent call last): File "<stdin>", line 1, in <module> AttributeError: 'A' object has no attribute '__val' >>> >>> a._A__val 1 >>> >>> a.f() 1 >>>継承

以下のようにしてクラスを継承する。

>>> class A: ... a = 1 ... >>> >>> class B(A): ... def f(self): ... print(self.a) ... >>> >>> b = B() >>> b.f() 1 >>>属性は全てvirtualなので、派生クラス側で上書きできる。

>>> class A: ... def f(self): ... print(self.val) ... >>> >>> class B(A): ... val = 5 ... >>> b = B() >>> >>> b.f() 5多重継承

以下のようにしてクラスを多重継承する。

メソッドの検索順は、多重継承時に記述した順番に依存する。>>> class A: ... def f(self): ... print("A.f is called.") ... >>> class B: ... def f(self): ... print("B.f is called.") ... >>> class C(A, b): ... pass ... >>> c = C() >>> c.f() A.f is called. >>> >>> class C2(B, A): ... pass ... >>> >>> c2 = C2() >>> c2.f() B.f is called.構造体

Cのような構造体は存在しないが、以下のように空のクラスで代用することがある。

>>> >>> class A: ... pass ... >>> a = A() >>> a.name = "test" >>> a.val = 5 >>>イテレータ

Pythonの各コンテナオブジェクトはイテレータが実装されているため、for文によりループで各要素にアクセス出来て便利。

イテレータは以下のように自作クラスに実装できる。$ cat iterator.py class A: def __init__(self, data): self.data = data self.index = 0 def __iter__(self): return self def __next__(self): if len(self.data) == self.index: raise StopIteration self.index += 1 return self.data[self.index - 1] >>> a = A("asdf") >>> for s in a: ... s ... 'a' 's' 'd' 'f'ジェネレータ (generator)

ジェネレータを利用することでイテレータを自動で作成できる。

これにより「iter」、「next」を実装する手間が省ける。$ cat generator.py class A: def __init__(self, data): self.data = data self.index = 0 def sequence(self): for i in range(len(self.data)): yield self.data[i] >>> a = A("asdf") >>> for s in a.sequence(): ... s ... 'a' 's' 'd' 'f'ジェネレータ式

リスト内包表記を括弧で囲ったものがジェネレータ式。

>>> g = (i * i for i in range(10)) >>> >>> g <generator object <genexpr> at 0x10522d7b0> >>> >>> list(g) [0, 1, 4, 9, 16, 25, 36, 49, 64, 81] >>> >>> list(g) [] >>> >>> g = (i * i for i in range(10)) >>> sum(g) 28510. 標準ライブラリミニツアー

os: OSとの対話

「from os import * 」と読み込むとopen()とos.open()が被るので「import os」と読み込む。

カレントディレクトリ取得 (os.getcwd())

>>> import os >>> os.getcwd() '/private/tmp'ディレクトリの移動 (os.chdir())

>>> os.chdir("/var") >>> os.getcwd() '/private/var' >>>シェルコマンド実行

>>> os.system("date") 2021年 2月22日 月曜日 18時19分04秒 JSTshutil: ファイル操作

ファイルコピー (shutil.copyfile)

>>> shutil.copyfile("aaa", "aaa2") 'aaa2' >>>glob: ファイルリスト取得

特定の拡張子のファイル一覧取得 (glob.glob())

>>> glob.glob("*.py") ['fibo.py', 'ccc.py', 'bbb.py', 'aaa.py', 'test.py', 'generator.py', 'iterator.py', 'sys.py']sys: システムパラメータ取得

コマンドライン引数 (sys.argv)

$ python -i aaa.py >>> import sys >>> sys.argv ['aaa.py']標準エラー出力 (sys.stderr.write())

>>> sys.stderr.write("test") 4 test>>> >>>スクリプトの終了 (sys.exit())

>>> sys.exit() $argparse: コマンドライン引数処理

プログラム名取得 (ArgumentParser.prog)

>>> parser = argparse.ArgumentParser() >>> parser.prog 'aaa.py' >>>re: 文字列のパターンマッチング

正規表現 (re.findall)

>>> import re >>> re.findall('asdf[a-z]*', "1234asdfwer78989") ['asdfwer']random: 乱数に基づいた要素選択

ランダムに要素を選択 (random.choice())

>>> import random >>> random.choice([1,2,3,4,5]) 3乱数の生成 (random.random())

>>> import random >>> random.random() 0.31780501360951163statistics: 統計

平均 (statistics.mean())

>>> import statistics >>> statistics.mean([1,3,5,7,9,11]) 6標本分散 (statistics.pvariance())

>>> import statistics >>> statistics.pvariance([1,3,5,7,9,11]) 11.666666666666666urllib: インターネットアクセス

GETリクエスト (urllib.urlopen)

>>> for line in urlopen("https://example.com"): ... line ... b'<!doctype html>\n' b'<html>\n' b'<head>\n' b' <title>Example Domain</title>\n' b'\n' b' <meta charset="utf-8" />\n' b' <meta http-equiv="Content-type" content="text/html; charset=utf-8" />\n' b' <meta name="viewport" content="width=device-width, initial-scale=1" />\n' b' <style type="text/css">\n' b' body {\n' ... ...datetime: 日時の操作

現在の日時取得

>>> import datetime >>> datetime.date.today() datetime.date(2021, 2, 22)gzip: データ圧縮

文字列の圧縮 (zlib.compress())

import zlib >>> s = b'This domain is for use in illustrative examples in documents. You may use this domain in literature without prior coordination or asking for permission.' >>> len(s) 152 >>> len(zlib.compress(s)) 113timeit: 実行時間計測

実行時間の計測 (timeit.timeit())

>>> timeit.timeit("[i * i for i in range(10)]") 0.4927712500000325 >>> >>> >>> timeit.timeit("[i * i for i in range(100)]") 3.143982625000035 >>>doctest: テスト

docstringに埋め込んだテストをdoctestモジュールで実行することが可能。

$ cat mytest.py def mytest1(a, b): """Calc sum of a and b. >>> print(mytest1(1, 2)) 4 """ return a + b if __name__ == "__main__": import doctest doctest.testmod() $ python mytest.py ********************************************************************** File "/private/tmp/mytest.py", line 4, in __main__.mytest1 Failed example: print(mytest1(1, 2)) Expected: 4 Got: 3 ********************************************************************** 1 items had failures: 1 of 1 in __main__.mytest1 ***Test Failed*** 1 failures.11. 標準ライブラリミニツアー --- その 2

reprlib: オブジェクトの省略表現

オブジェクトの文字列表現 (repr())

eval()によってオブジェクトに戻せるような文字列に変換する。

>>> import datetime >>> a = datetime.datetime.today() >>> str(a) '2021-02-23 23:52:09.178283' >>> repr(a) 'datetime.datetime(2021, 2, 23, 23, 52, 9, 178283)' >>> >>> b = eval( repr(a) ) >>> b datetime.datetime(2021, 2, 23, 23, 52, 9, 178283) >>>オブジェクトの省略表現 (reprlib.repr())

デバッグ用途等のため、オブジェクトをrepr()の短縮版に変換する。

>>> import reprlib >>> a = datetime.datetime.today() >>> repr(a) 'datetime.datetime(2021, 2, 23, 23, 52, 9, 178283)' >>> >>> reprlib.repr(a) 'datetime.date...52, 9, 178283)' >>>pprint: オブジェクトの表示制御

改行表示 (pprint.pprint())

>>> import pprint >>> a = {"a": 1, "b": [1,2,3], "c": "zxcv"} >>> a {'a': 1, 'b': [1, 2, 3], 'c': 'zxcv'} >>> >>> pprint.pprint(a, width=5) {'a': 1, 'b': [1, 2, 3], 'c': 'zxcv'} >>>textwrap: テキストの折り返しと詰め込み

文章の表示幅制限 (textwrap.fill())

>>> a = "Lorem ipsum dolor sit amet, consectetur adipiscing elit. Quisque egestas ex a orci fringilla finibus. " >>> print(textwrap.fill(a, width=20)) Lorem ipsum dolor sit amet, consectetur adipiscing elit. Quisque egestas ex a orci fringilla finibus.locale: 国際化

通貨の表示 (locale.currency())

>>> locale.setlocale(locale.LC_ALL, '') 'ja_JP.UTF-8' >>> >>> locale.currency(12345678) '¥12345678' >>> >>> locale.currency(12345678, grouping=True) '¥12,345,678'string: 文字列テンプレート

変数展開 (string.substitute())

>>> from string import Template >>> t = Template('a: ${a}, b: ${b}') >>> t.substitute(a = "aaa", b = "bbb") 'a: aaa, b: bbb'struct: バイナリデータ処理

数値 - バイナリ間の変換 (struct.pack(), struct.unpack())

>>> a = struct.pack('b', 127) >>> a b'\x7f' >>> type(a) <class 'bytes'> >>> struct.unpack('b', a) (127,)threading: マルチスレッド

##### スレッド作成 (threding.Thread())

>>> import threading >>> import time >>> >>> class A: ... val = 0 ... def test(self): ... time.sleep(3) ... self.val = 100 >>> >>> th = threading.Thread(target = a.test) >>> th.start() >>> >>> a.val 0 >>> a.val 100logging: ログ

##### 標準エラー出力 (logging.error())

>>> import logging >>> logging.error("test") ERROR:root:testweakref: 弱参照

pythonのGCはリファレンスカウンタ方式なので、delによって削除を行っても参照されている限りメモリが開放されない。

weakrefを利用すると、参照先が削除された際にメモリが開放されるような弱参照の辞書を作成できる。弱参照辞書 (weakref.WeakValueDictionary())

>>> a = User("asdf") >>> a <__main__.User object at 0x103649b20> >>> b = {"user": a} >>> b {'user': <__main__.User object at 0x103649b20>} >>> del a >>> b["user"] <__main__.User object at 0x103649b20> >>> b["user"].name 'asdf' >>> import weakref >>> a = User("asdf") >>> a <__main__.User object at 0x1035db7c0> >>> b = weakref.WeakValueDictionary({"user": a}) >>> b <WeakValueDictionary at 0x10366f4f0> >>> b["user"].name 'asdf' >>> del a >>> >>> b["user"] Traceback (most recent call last): File "<stdin>", line 1, in <module> File "/opt/homebrew/Cellar/python@3.9/3.9.1_6/Frameworks/Python.framework/Versions/3.9/lib/python3.9/weakref.py", line 134, in __getitem__ o = self.data[key]() KeyError: 'user' >>>array: 配列

arrayはlist型と違って指定した型のデータしか受け入れない代わりに、コンパクトな配列を作成できる。

バイト型の配列 (array.array('b', ...))

>>> import sys >>> import array >>> >>> a = [1,2,3] >>> b = array.array('b',[1,2,3]) >>> >>> sys.getsizeof(a) 120 >>> sys.getsizeof(b) 67decimal: 浮動小数演算

浮動小数点誤差が出ると困る場合、decimalモジュールで精度を指定して演算を行う。

>>> 0.1 + 0.2 0.30000000000000004 >>> decimal.Decimal(0.1) + decimal.Decimal(0.2) Decimal('0.3000000000000000166533453694') >>> decimal.getcontext().prec = 2 >>> decimal.Decimal(0.1) + decimal.Decimal(0.2) Decimal('0.30')12. 仮想環境とパッケージ

pip install等でモジュールをインストールする環境を分けたい場合、venvを利用してディレクトリ単位の仮想環境を作成する。

$ py -m venv my-project $ cat my-project/pyvenv.cfg home = /opt/homebrew/bin include-system-site-packages = false version = 3.9.113. さあ何を?

リンク集。

14. 対話入力編集と履歴置換

対話シェルの種類

bpython

入力補完とドキュメントの表示が強力な対話シェル。

[https://www.bpython-interpreter.org/]

$ brew install bpython対話シェルでの実行履歴

デフォルトで以下のファイルに保存される。

$ cat ~/.python_history15. 浮動小数点演算、その問題と制限

丸め誤差

浮動小数点の丸め誤差に注意。

round()で適宜計算結果を丸める等の対策が必要。>>> 0.1 + 0.1 == 0.2 True >>> 0.1 + 0.1 + 0.1 == 0.3 False >>> >>> round(0.1 + 0.1 + 0.1, 2) == 0.3 True16. 付録

対話モード起動時に読み込むスクリプト

環境変数「PYTHONSTARTUP」に指定されたパスのスクリプトは対話モードの開始時に読み込まれる。

よく利用するモジュールのimportや自作のちょっとしたモジュールはここに書いておくと便利。# ~/.zshrc ... export PYTHONSTARTUP=~/.python_startup.py ... # ~/.python_startup.py def myfunc(): print("test") $ python Python 3.9.2 (default, Feb 19 2021, 06:54:56) [Clang 12.0.0 (clang-1200.0.32.29)] on darwin Type "help", "copyright", "credits" or "license" for more information. >>> >>> myfunc() test >>>実行可能なPythonスクリプト

スクリプトにシバンを書き、実行権限を付与しておくと、直接実行できて便利。

$ cat test.py #!/usr/bin/env python3 def run(): print("run func is called.") if __name__ == "__main__": run() $ chmod a+x test.py $ ./test.py run func is called.

- 投稿日:2021-02-25T19:13:09+09:00

scoop 環境下での python 周りの SSL エラー

scoop で anaconda や python を入れていたら SSL エラーが出るように。具体的には pip や anaconda (conda コマンド) で https につないだ通信でエラーになる。

certificate verify failedとか$ conda update anaconda-navigator Collecting package metadata (current_repodata.json): failed CondaHTTPError: HTTP 000 CONNECTION FAILED for url <https://repo.anaconda.com/pkgs/main/win-64/current_repodata.json> Elapsed: -とかが発生する。

解決法

家の環境では↓で直った。

$ scoop install openssl $ pip install pyopenssl $ conda update conda再発したときに忘れてそうなのでメモ。

- 投稿日:2021-02-25T19:09:37+09:00

初心者が深層学習で小説の文章から感想を生成しようとした話

はじめに

小説の文章から内容を考慮した感想を自動生成したいと思い、ちょうど機会があったので挑戦してみました。半年ぐらいで「ゼロから作るDeepLearning」の1と2を一通り読み、残り半年で実装しました。せっかく頑張ったので記録用に書いてます。

作業の流れ

次のような順番で実装しました。

- データ収集

- データの前処理

- 学習

- 生成

これから順を追って説明していきます。

データ収集

学習するためには大量のデータが必要です。モデルには本文と感想をペアにして入力するので、小説の本文と感想をセットで入手する必要があります。今回は「小説家になろう」と「カクヨム」からスクレイピングして集めました。

小説家になろう

小説家になろうでは最近(2019年ぐらい?)から作品の一話ずつに感想が書き込めるようになりました。そこで本文ページとその感想ページを行き来するクローラーを作成しました。

- 作品ページ

- 本文ページ

- 感想ページ

- 本文ページ

- 感想ページ

簡単に説明すると、上のような構造になっているので、作品ページのURLから一話の本文ページのURLを取得し、本文データと感想ページのURLを集め、感想ページの感想データを収集する。これを本文ページの次の話のリンクがなくなるまで続け、終わったら次の作品ページという様に繰り返す。

なろうは静的なサイトでhtmlの構造もわかりやすかったので簡単に集めることができました。本文データはあとで一文づつに分割したいので改行をすべて「/」に変換して一文にし、本文データと感想データが一対一になるように保存しました。

PythonはBeautifulSoupのようなライブラリが充実しているので、簡単にスクレイピングできます。ヘッダー情報としてユーザエージェントがいるので、忘れないようにしましょう。

データは小説の本文を約2.5GBほど集めました。

カクヨム

小説家になろうの一話ごとに感想が対応するシステムは比較的最近ついた機能なので、データ数が足りなかったのでカクヨムからも集めました。カクヨムは小説家になろうとは違い、動的なサイトであるため、感想の欄(カクヨムでは応援コメント)をクリックして読み込む必要がある。そこでseleniumを用いて感想欄を読み込んでからhtmlを読み込むようにしてデータを集めました。

こちらは約1GBほど集めました。

データの前処理

現在の深層学習モデルではTransformerを用いても小説全文を入力することはできません。そこで入力に使うデータは感想に対応する数文をとってくる必要があります。また、スクレイピングして集めてきた感想データには学習データとして不適切なものも混ざっています。前処理の流れはざっくりと次のようになります。

- 本文から感想に対応する数文を取ってくる

- テキストデータを掃除する

本文から感想に対応する数文を取ってくる

感想は小説全体を指しての感想もあると思いますが、今回は一話の一部分に対しての感想を考えます。感想は小説の一部分を参考にして書くとすると、感想に出てきて小説にも出てくる単語は感想を書く上で重要な単語のはずです。よって、感想で出てくる単語を重みづけして、それを利用して数文取り出すようにします。

そこで使うのがTF-IDFです。TFはTerm Frequencyを表し、これは単語の出現頻度のことです。IDFはInverse Document Frequencyで、これはある単語が含まれる文書の割合の逆数のことです。TF-IDFはTF値とIDF値をかけ合わせて計算します。TF-IDFはその文章で出現回数は多いが、他の文書では出現していない単語のTF-IDFの値は大きくなり,それ以外の単語についてはTF-IDF値は相対的に小さくなります。簡単にいうと、頻度を考慮して単語毎の重要度を算出することができます。つまりは、その文章の中でよく出る人物名などの固有名詞の重要度を上げることができます。ちなみにTF-IDFの計算はsklearnにTfidfVectorizerがあるのでこれを使いました。

単語の分割にはMeCabを使用しました。MeCabはオープンソースの形態素解析エンジンで日本語を形態素に分割するツールです。こちらもmecab-python-windowsを使用するとPython上で利用できます。

さて、TF-IDFで単語の重みづけができたら、本文データを一文づつに分割して学習に使う数文を選びます。今回は三文選ぶことにします。一文づつに分けたものをさらにMeCabで単語に単語に分割して、一文ごとに単語の重みを合計します。このままでは長い文ほど合計が高くなる可能性が高くなってしまうので、長さで正規化します。この数値が大きい三文を用いて学習します。Transformerで学習するとき、複数文をつないでいることがわかるようにタグでつなぎます。

文[タグ]文[タグ]文

これで上のようになります。

テキストデータの掃除

スクレイピングで集めてきた感想データには「更新ありがとうございました」や「次回も楽しみにしています」のような本文の内容には関係のない感想や誤字報告などが混ざっています。これらはどの小説でも一定数存在しているので何もせず学習すると、本文と感想との対応を学習しづらくなり適切に学習できません。

そこで今回は次の2つで掃除しました。

- 感想の文章の長さが短いものを外す

- 本文に関係のない単語が出ている文を外す

まず、感想の文章の長さが短いものを外すのは、短いものはそもそも内容に触れていないものが多いと感じたからです。内容に対する感想を出力したいのでこれは外します。

次に、本文に関係のない単語が出ている文を外すことに関してです。こちらも内容に対する感想を出力するために邪魔になるので排除します。本文に関係のない単語は「更新」、「誤字」、url、「次回」、「著者」、「書籍化」などいくつか実際に感想を見て、いらないと思った単語をリストにしました。MeCabで分割してこの単語を含む文は使わないようにしました。前処理の流れ

最後に前処理流れをもう一度まとめます。

- 感想のTF-IDFを取り、単語に重みづけする

- このとき、データの掃除も行う

- 本文を一文づつに分割し、一文ごとに出てきた単語の重みの合計を求める

- 長さで正規化する

- 数値の大きい三文を取りだし、タグでつなぐ

学習

いよいよ学習です。学習する上での方針は「本文に出現する単語を感想にも出現させたい」ということです。普通の翻訳モデルでは入力と出力の単語は別々にされています。翻訳モデルでは日本語と英語のようにはっきりとわかれているので単語が混ざってはいけないからです。そこで今回は要約モデルを使います。要約モデルを使うことで単語辞書やembeddingを入力と出力で共有することができます。これによって小説に出てきた登場人物や固有名詞を感想に出現させることができるようになることを期待しています。

今回モデルを自分で一から作るのは厳しかったので、オープンソースの機械翻訳エンジンであるopenNMTを用いました。特にpytorchを使ったopenNMT-pyを使用しています。ドキュメントはこちらです。こちらを使うことでモデルを一から作ることなく、手軽に高性能なモデルを使えます。便利ですね。デフォルトでは機械翻訳用なのですが、パラメータを設定することで要約モデルでの学習もできます。モデルは最近ではRNNよりTransformerの方が高性能で主流のようなので、Transformerを使います。Transformerの説明はこちらかこちらあたりがわかやりやすいと思います。

学習データは前処理を行った本文と感想のペアを約18万ペア用います。

さて、ではまずopenNMT-pyの前処理を行っていきます。コマンド一つで簡単にできます。

onmt_preprocess -train_src data/train_body.txt -train_tgt data/train_comment.txt -valid_src data/valid_body.txt -valid_tgt data/valid_comment.txt -save_data naro -src_seq_length 400 -tgt_seq_length 400 -dynamic_dict -share_vocabこれだけで学習用の語彙データが作れます。特徴的なのはdynamic_dictとshare_vocabです。dtnamic_dictは生成時に入力された文も辞書に加えて生成するようにします。これによって、生成時に入力された文から単語を取り出して出力に出現させることが可能になります。share_vocabは入力データと出力データの辞書データを共有します。翻訳モデルの場合では日本語と英語のように混ざってはいけないが、今回は入力と出力が両方日本語で混ざっても大丈夫なので、辞書データを共有することで語彙数を増やしつつ、共通する語を省けるので動作を軽くできます。

次に、作った語彙データを用いて学習していきます。

onmt_train -data naro -save_model naro-model -layers 8 -rnn_size 1024 -word_vec_size 1024 -transformer_ff 4096 -heads 8 -encoder_type transformer -decoder_type transformer -position_encoding -train_steps 300000 -max_generator_batches 2 -dropout 0.1 -batch_size 4096 -batch_type tokens -normalization tokens -accum_count 4 -optim adam -adam_beta2 0.998 -decay_method noam -warmup_steps 8000 -learning_rate 0.01 -max_grad_norm 0 -param_init 0 -param_init_glorot -label_smoothing 0.1 -valid_steps 2500 -save_checkpoint_steps 2500 -world_size 2 -gpu_rank 0 1 -share_embedding -copy_attn今回はGPU2台を用いて学習しました。オプションの詳しい説明はドキュメントを見てください。特徴的なのはshare_embeddingとcopy_attnです。share_embeddingはそのままの意味でencoderとdecoderでembeddingを共有するようにします。これもshare_vocabと狙いは同じで、embeddingを共有することで一つのembeddingで計算できるので動作を軽くできます。copy_attnはdynamic_dictと対応しています。dynamic_dictと合わせることで生成時に入力の単語を出力に出現させることができるようになります。

生成

学習ができれば、実際に生成します。しかし、学習用データと同様に、入力に小説全文を使うことはできないので、生成の入力データ用に適切に数文を選ぶ必要があります。その後、openNMT-pyのtranslateを用いて生成します。

生成用入力データの作成

当然ですが、ここでの入力データは学習に使った入力データとできるだけ近い構造でないとモデルが学習できていても、生成時にうまく生成することができません。そこで、生成用の入力データは学習用の入力データに近づける必要があるのですが、学習用の入力データは出力データである感想に対して取り出しています。生成時には小説データしかないので、これだけで学習用の入力データに近づける必要があります。

ここで、学習用の入力データは感想中の単語を重みにして選んでいるので、小説から選ばれる3文は似たような単語、文章になっていると考えました。そこで、生成用の文章でも三文が似たような単語、文章になるようにします。ここでも前処理で使ったTF-IDFを用います。入力データの作成の流れは次のようになります。

- 一文ずつに分けた小説データに対してTF-IDFを取り、単語に重みづけをする

- その重みを用いて、合計値が最も大きい一文を選ぶ

- 一文ずつに分けた小説データをベクトル化し、コサイン類似度をとる

- TF-IDFの最も大きい文とコサイン類似度が大きい2つはタグでつなぐ

TF-IDFで単語に重みづけをし、まずは一文を決めます。その後、それに似た文を選ぶためコサイン類似度で似たものを探します。コサイン類似度はベクトルがどれだけ同じ方向に向いているかを計算します。自然言語処理では単語をベクトル化することでコンピュータで扱えるようにし、うまくできればベクトルの足し引きで単語を推測できることも知られています。これを用いることで最初に選んだ一文と似ているであろうと思われる二文を選び、生成用の入力データにします。

openNMT-pyによる生成

前処理、学習と同じでコマンド一つで生成できます。

onmt_translate -gpu 0 -batch_size 10 -model data/naro-model_step_62500.pt -src data/test.txt -output pred.txt -min_length 15 -verbose -stepwise_penalty -coverage_penalty summary -beta 5 -length_penalty wu -alpha 0.9 -block_ngram_repeat 2 -ignore_when_blocking "." "[SEN]" "。" -replace_unkいろいろと書いてますが、簡単にいうとビームサーチで生成するということと長さや繰り返しにペナルティを与えていることが書いています。詳しくはドキュメントを見てください。

結果

お待ちかねの結果です。いくつか生成した例を載せます。

test.txt「 しかし 、 あの よう な やり方 で 一方 的 に 公爵 令嬢 が 排除 さ れ た と なる と 、 他 の 貴族 家 も 安泰 で は 無くなり ます 。 すると その 先 に 待つ の は 王 太子 殿下 と 第 二 王子 殿下 の 継承 権 争い です 。 過去 の 歴史 を 振り返っ て も この 争い は 非常 に 危険 で 、 多く の 血 が 流れ 、 国 は 乱れる こと でしょ う 」 [SEN] 「 ですが 、 そんな 決闘 で も 決闘 です 。 あの まま アナスタシア 様 が ご 自身 で 決闘 に 臨ま れ た 場合 、 アナスタシア 様 に 殿下 を 傷つける こと は でき ない でしょ う から 、 おそらく 敗れ た はず です 」 [SEN] 「 さて 、 まず 昨晩 は 娘 の 代理人 として 王 太子 殿下 や クロード 王子 と 決闘 を し て くれ た そう だ な 。 この 点 について は 礼 を 言お う 。 アレン 君 、 ありがとう 」pred.txt王 太子 と 第 二 王子 の 継承 権 争い が 勃発 し そう です なこれは小説の内容を言い換えして、語尾を変換したような感想になっています。

test.txtつまり 、 フロレスクルス 公爵 家 として は 、 ナゼルバート 様 が 王女 の 伴侶 に なっ て も 、 ロビン 様 の 子供 が 次 の 国王 に なっ て も 、 どちら でも 良く て 、 「 できれ ば 、 御し やすい 王女 殿下 と ロビン 様 の 子供 が 王 に なっ て くれ た 方 が いい かも 」 なんて 考え を 持っ て いる という こと だ 。 [SEN] 「 俺 を 正式 な 夫 に 、 ロビン 殿 を 愛人 として 迎え入れる ん だって 。 で 、 ロビン 殿 と ミーア 王女 の 子供 が 男 だっ たら 、 その 子 が 次 の 王 だ 」 [SEN] もともと 、 ナゼルバート 様 と 結婚 する の を 条件 に 、 王女 殿下 は 次期 女王 に なる こと を 認め られ て い た らしい 。 というのも 、 王女 殿下 は 全く 政治 の 勉強 を し て い ない から だ 。pred.txt王 太子 は ロビン を 傀儡 に する つもり だっ た の か な ?これも、小説の内容を言い換えている感想になります。個人的に入力で出てこない傀儡という単語が出てきたのが面白いと思います。しかし、名詞の当てはめで間違っています。

test.txt帝国 と バークレイ 産 の 麦 の 取引 、 及び レナート と マリ アベル の 婚姻 に 際 する 条件 について は 、 予定 さ れ て いる 二 人 の 運命 の 出会い の 前 に 条件 を 詰める こと に なっ て いる 。 [SEN] その間 に 、 マリ アベル は 帝国 独自 の マナー など を 教え て もらっ た 。 [SEN] 帝国 の 皇太子 と も なれ ば 、 その 予定 は びっしり と 詰まっ て いる こと だろ う 。pred.txtマリ アベル と 皇太子 の 仲 が 進展 し そう な 気 が し ます感想でよく出現するテンプレパターンです。

test.txt「 とりあえず この 辺り で 肩 慣らし を し て … … 単純 に リエル が 戦闘 に 慣れる 練習 を しよ う か 。 ファースト スキル の 死ん だ フリ も 何 度 も 使っ て いれ ば ドンドン 精度 や スキル 技能 が 向上 する はず だ 。 まずは 死ん だ フリ を 強化 し て 行こ う 」 [SEN] どこ の 世界 に 死ん だ フリ の 技能 を 向上 する ため に 修練 を する なんて 話 が ある の だろ う か 。 [SEN] 「 リエル 、 今 一 度 君 の 最強 スキル 、 死ん だ フリ と 真剣 に 向き合っ て ほしい 」pred.txt「 とりあえず この 辺り で 肩 慣らし を し て … … 単純 に リエル が 戦闘 中 に 死ん だ フリ を しよ う か 。 ファースト スキル の 死ん だ フリ も 何 度 も 使っ て いれ ば ドンドン 精度 が 向上 する はず だ 。 」 この 部分 の 最強 スキル だ と 思っ たなんと本文を引用して、感想を出力しています。

ここまで見ると、それなりの感想が出力されているように見えますが、これは少数のよさそうなものを取ってきた例です。実際はほとんどのものは日本語がおかしかったり、名詞の当てはめで間違っていたりしています。ダメな例をいくつか載せておきます。

pred.txtロビン が 腕 を 飲む こと は 出来 ない ん じゃ ない か な ? エレイン と エレイン の コンビ は 結構 好き な ん じゃ ない か な 。 シャナル の 「 シャナル さん 、 人質 って こと に なっ て もらっ て いい よ 」 エルフ たち は エルフ の 国 の こと を 知っ て いる の でしょ う か ? 剣 聖 の 剣 と 剣 の 関係 性 が 出 て き まし た 。 犬 人 型 の 犬 、 猫 耳 と 尻尾 を 装着 し て ます アスラ かっこいい ! グンドウ と グンドウ を 回収 し まし た ね !ですので、うまくできたモデルを作れたという結果にはなりませんでした。

簡単な考察

語尾の偏り

生成した感想では語尾に一定のパターンができていた。例えば、「かな?」「気になります」「でしょうか?」「良いのでは?」のようなものです。前者2つは人間が書く感想でもよく見られる語尾なので良いのですが、「気になります」が多すぎる問題があります。「~と~の関係が気になります!」のような文がよく生成されます。これは学習データにある感想にこのような文が多かったのだと思われます。後者2つはおそらく誤字を指摘するコメントから来たものだと考えています。小説家になろうやカクヨムの感想ではそういった感想ではなく誤字を指摘するコメントが見られます。一応「誤字」といったキーワードで排除したのですが、排除できていないものが多そうなので、確実に排除する必要があります。

感想の傾向

出力された感想はいくつかのパターン当てはまってるように感じました。

まず本文の内容を言い換え、語尾を変換したものです。これは「~ですよね?」のような疑問形や確認する形に変換されている例をよく見ます。

次に、「~気になります」、「~が好きです」、「~と~の関係」、「~の今後」のようなテンプレに対して単語を当てはめたものです。これは実際の感想でもよく見られるので単語の当てはめがうまくいけば感想っぽく見えます。しかし、実際に単語の当てはめがうまくいっているものは少ないです。~と~のような並列の単語当てはめでは、まったく関係がない2つを選んだり、2つとも同じ単語が入ったりすることが頻出します。

最後に、本文から引用して一言のパターンです。これは入力データから文を取ってきて最後に何か一文付け加えているものです。引用しているので違和感があれば目立ちます。これは誤字指摘のコメントから来ていると考えています。相当する一文を引用して、ここがこっちのほうがいいと思います、という内容の誤字指摘から一文引用と一言というパターンができたと考えました。これも誤字を指摘するコメントの排除が不十分だったことを表しているので、前処理が課題になっていることがわかります。

たまに出現する変わったものとしてメタ的な感想を出力することがあります。例えば、「ヒロインは~ですね」みたいな内容です。モデルでは実際に内容を理解しているわけではないので、名詞の当てはめに間違う確率が高く、間違っていると目立ちます。でも、合っていると人間が書いた感想のようになります。

課題

今回の課題点をまとめてみました。

- 全体的に日本語がおかしい

- 要モデルの改善

- 名詞の当てはめ

- 特定の語尾に偏り

- 前処理での排除

- 感想に関係がない単語の排除

- 前処理での排除

- データ数

- そもそも学習データが減るため思い切った前処理ができなかった

- 前処理で徹底して排除するにはより多くのデータが必要

まとめ

要約モデルを用いて小説の本文から感想の出力を行いました。全体的な性能としてはよいとは言えませんが、一部でも感想らしいもの生成されたのでよかったです。一番大きな課題は名詞の当てはめです。有識者に聞いた限り、名詞の当てはめ問題はかなり大きなモデルを使っても起こるらしいので難しいそうです。

今後は、データ数を増やし、質のいい学習データを作り、モデルの改善を行っていきたいと考えています。前処理での工夫余地はあって、タグを増やしてネガティブ、ポジティブで分類したり、本文以外の情報、例えば登場人物やあらすじを入力データにくっつけるなども考えています。

うまくできたらTwitterBotや小説の内容を考慮した対話システムも作ってみたい(願望)。

自然言語処理や深層学習に触る体験ができたので自分の中では割と満足しています。

- 投稿日:2021-02-25T19:07:56+09:00

入力待ち(wait for input)のsubprocessにinputを送る

概要

subprocessで起動したプロセスが入力待ちになったタイミングで、外部から入力を送りたい場面があります。

業務の中でPythonでこれを行うときになかなか苦戦したので記しておきます。標準入出力

サブプロセスとして起動する以下のようなプログラムを想定します。

sub.pyimport time if __name__ == "__main__": while True: time.sleep(5) user_input = input("wait for input :") print(f"User Input is {user_input}")五秒ごとにユーザーからの入力を受け付けるいたってシンプルなプログラムです。

これをサブプロセスとしてメインプロセスから起動します。__main__.pyfrom subprocess import Popen import sys import time p = Popen( args=["python", "sub.py"], stdin=sys.stdin, stdout=sys.stdout ) while True: time.sleep(1)コンソールの標準出力と標準入力をサブプロセスに引き渡しているので、当然コンソール画面から入出力ができます。

>> python __main__.py wait for input : abcdefg User Input is abcdefgIOインターフェースの引き渡し

標準入出力が使えれば世話はないですが、それ以外のioインターフェスを利用したい場合はどうすればよいでしょうか。

試しに以下のコードを実行してみます。__main__.pyimport io stdin = io.BytesIO() p = Popen( args=["python", "sub.py"], stdin=stdin, stdout=sys.stdout )すると以下のエラーが発生します。

io.UnsupportedOperation: fileno

ioをプロセス間で共有する場合、file descriptorを利用する必要があります。

mainプロセスで宣言されたBytesIOは、あくまでPythonのメインプロセス内に限定されたioインターフェースで、OSレベルの利用を想定したものではありません。pythonのIOインターフェースの読み込み

pythonでは

IO.read(size=-1)でストリームを読み込むことができます。

sizeを指定しない場合は、EOFまで読み込んでくれますが、

os.fdopenで開けたストリームはブロッキングで開かれているため、

指定したサイズのバッファが来るまで待ち続けます。

つまり普通にstdoutを読み込んでしまうと、サブプロセスが入力待ちになった時点で、ブロックされてしまいます。よって

IO.read(1)として、1 byteずつ読み込むことで、サブプロセスが入力待ちになる直前までのアウトプットを取得することができます。下記のコードはサブプロセスからのoutputを受けて、入力待ちになった段階で別プロセスから入力を送るプログラムです。

以下の二つの処理を別スレッドでwhile loopで回し続けています。

- stdoutの読み込み

- subprocessが入力待ちになった時点で入力の送信

main.pyfrom subprocess import Popen, PIPE import time import sys import io import os import threading from dataclasses import dataclass @dataclass class SubprocessStatus: wait_for_input: bool @property def is_wait(self): pass @is_wait.getter def is_wait(self): return self.wait_for_input @is_wait.setter def is_wait(self, is_wait): self.wait_for_input = is_wait class Threadable: def thread_target(self): pass def start(self): self.t = threading.Thread(target=self.thread_target) self.t.setDaemon(True) self.t.start() class ProcessWatcher(Threadable): """ processがwait for inputになったらcallback """ subprocess_status: SubprocessStatus def __init__(self, subprocess_status, callback): self.subprocess_status = subprocess_status self.callback = callback def wait(self): time.sleep(1) def thread_target(self): while True: self.wait() if not self.subprocess_status.is_wait: continue self.callback() class StdoutLineReader(Threadable): """ stdoutを1 byteずつ読み込んで、行として処理 """ line = b"" def __init__(self, fd_stdout: int, callback): self.fd_stdout = fd_stdout self.callback = callback def thread_target(self): self.stdout = os.fdopen(self.fd_stdout, "rb") linesep = os.linesep.encode() while True: r = self.stdout.read(1) self.line += r self.callback(self.line) if self.line.endswith(linesep): print("line :", self.line) self.line = b"" class MainProcess: count = 0 target_line = b"wait for input" def __init__(self): self.fd_stdin_r, self.fd_stdin_w = os.pipe() self.fd_stdout_r, self.fd_stdout_w = os.pipe() self.stdout_w = os.fdopen(self.fd_stdin_w, "wb") self.subprocess_status = SubprocessStatus(False) self.stdout_line_reader = StdoutLineReader( self.fd_stdout_r, self.handle_line) self.process_watcher = ProcessWatcher( self.subprocess_status, self.when_wait_for_input) def handle_line(self, line: bytes): if not line.startswith(self.target_line): return self.subprocess_status.wait_for_input = True def when_wait_for_input(self): self.subprocess_status.wait_for_input = False self.stdout_w.write(f'Input:{self.count}\n'.encode()) self.stdout_w.flush() self.count += 1 def start(self): self.process = Popen( args=["python", "sub.py"], stdin=self.fd_stdin_r, stdout=self.fd_stdout_w, stderr=sys.stderr ) self.stdout_line_reader.start() self.process_watcher.start() main_process = MainProcess() main_process.start() while True: time.sleep(1)詳細

サブプロセスの状態とstdoutからの出力は当然誤差があるため、

SubprocessStatusを作成して、サブプロセスの状態を仮想的に制御します。StdoutLineReaderはstdoutを一文字ずつ読み続け、改行コードが出現した段階で、リフレッシュします。別スレッドで動かすことで、入力待ち時のブロッキングを回避します。

ProcessWatcherでサブプロセスの状態を監視させ、wait for inputになった時点で

callbackを呼び出します。仕様かやり方が悪いのかわかりませんが、openしたfile descriptorについて、一度closeしててから、同一のfile descriptorを再びopenしようとするとOS errorが出ます。

よって、stdinに使うfile descriptorについては開いたままにしています。※Popen.communicateについて

サブプロセスへの入力が一度きりの場合については、popenのcommunicateが利用できます。ほかの記事を参考にしてみてください。

- 投稿日:2021-02-25T19:07:56+09:00

Python : 入力待ち(wait for input)のsubprocessにinputを送る

概要

subprocessで起動したプロセスが入力待ちになったタイミングで、外部から入力を送りたい場面があります。

業務の中でPythonでこれを行うときになかなか苦戦したので記しておきます。標準入出力

サブプロセスとして起動する以下のようなプログラムを想定します。

sub.pyimport time if __name__ == "__main__": while True: time.sleep(5) user_input = input("wait for input :") print(f"User Input is {user_input}")五秒ごとにユーザーからの入力を受け付けるいたってシンプルなプログラムです。

これをサブプロセスとしてメインプロセスから起動します。__main__.pyfrom subprocess import Popen import sys import time p = Popen( args=["python", "sub.py"], stdin=sys.stdin, stdout=sys.stdout ) while True: time.sleep(1)コンソールの標準出力と標準入力をサブプロセスに引き渡しているので、当然コンソール画面から入出力ができます。

>> python __main__.py wait for input : abcdefg User Input is abcdefgIOインターフェースの引き渡し

標準入出力を使えれば世話はないですが、それ以外のioインターフェスを利用したい場合はどうすればよいでしょうか。

試しに以下のコードを実行してみます。__main__.pyimport io stdin = io.BytesIO() p = Popen( args=["python", "sub.py"], stdin=stdin, stdout=sys.stdout )すると以下のエラーが発生します。

io.UnsupportedOperation: filenoストリームをプロセス間で共有する場合、file descriptorを利用する必要があります。

mainプロセスで宣言されたBytesIOは、あくまでPythonのメインプロセス内に限定されたioインターフェースで、OSレベルの利用を想定したものではありません。pythonのIOインターフェースの読み込み

そこで、osモジュールのpipeメソッドで作ったfile descriptorを利用して、ストリームの共有を図ります。

pythonでは

IO.read(size=-1)でストリームを読み込むことができます。

sizeを指定しない場合は、EOFまで読み込んでくれますが、

os.fdopenで開けたストリームはブロッキングで開かれているため、

指定したサイズのバッファが来るまで待ち続けます。

つまり普通にstdoutを読み込んでしまうと、サブプロセスが入力待ちになった時点で、ブロックされてしまいます。よって

IO.read(1)として、1 byteずつ別スレッドで読み込むことで、サブプロセスが入力待ちになる直前までのアウトプットを取得するアプローチを取ります。下記のコードはサブプロセスからのoutputを受けて、入力待ちになった段階で別プロセスから入力を送るプログラムです。

以下の二つの処理を別スレッドでwhile loopで回し続けています。

- stdoutの読み込み

- subprocessが入力待ちになった時点で入力の送信

main.pyfrom subprocess import Popen, PIPE import time import sys import io import os import threading from dataclasses import dataclass @dataclass class SubprocessStatus: wait_for_input: bool @property def is_wait(self): pass @is_wait.getter def is_wait(self): return self.wait_for_input @is_wait.setter def is_wait(self, is_wait): self.wait_for_input = is_wait class Threadable: def thread_target(self): pass def start(self): self.t = threading.Thread(target=self.thread_target) self.t.setDaemon(True) self.t.start() class ProcessWatcher(Threadable): """ processがwait for inputになったらcallback """ subprocess_status: SubprocessStatus def __init__(self, subprocess_status, callback): self.subprocess_status = subprocess_status self.callback = callback def wait(self): time.sleep(1) def thread_target(self): while True: self.wait() if not self.subprocess_status.is_wait: continue self.callback() class StdoutLineReader(Threadable): """ stdoutを1 byteずつ読み込んで、行として処理 """ line = b"" def __init__(self, fd_stdout: int, callback): self.fd_stdout = fd_stdout self.callback = callback def thread_target(self): self.stdout = os.fdopen(self.fd_stdout, "rb") linesep = os.linesep.encode() while True: r = self.stdout.read(1) self.line += r self.callback(self.line) if self.line.endswith(linesep): print("line :", self.line) self.line = b"" class MainProcess: count = 0 target_line = b"wait for input" def __init__(self): self.fd_stdin_r, self.fd_stdin_w = os.pipe() self.fd_stdout_r, self.fd_stdout_w = os.pipe() self.stdout_w = os.fdopen(self.fd_stdin_w, "wb") self.subprocess_status = SubprocessStatus(False) self.stdout_line_reader = StdoutLineReader( self.fd_stdout_r, self.handle_line) self.process_watcher = ProcessWatcher( self.subprocess_status, self.when_wait_for_input) def handle_line(self, line: bytes): if not line.startswith(self.target_line): return self.subprocess_status.wait_for_input = True def when_wait_for_input(self): self.subprocess_status.wait_for_input = False self.stdout_w.write(f'Input:{self.count}\n'.encode()) self.stdout_w.flush() self.count += 1 def start(self): self.process = Popen( args=["python", "sub.py"], stdin=self.fd_stdin_r, stdout=self.fd_stdout_w, stderr=sys.stderr ) self.stdout_line_reader.start() self.process_watcher.start() main_process = MainProcess() main_process.start() while True: time.sleep(1)詳細

サブプロセスの状態とstdoutからの出力は当然誤差があるため、

SubprocessStatusを作成して、サブプロセスの状態を仮想的に制御します。StdoutLineReaderはstdoutを一文字ずつ読み続け、改行コードが出現した段階で、リフレッシュします。別スレッドで動かすことで、入力待ち時のブロッキングを回避します。

ProcessWatcherでサブプロセスの状態を監視させ、wait for inputになった時点で

callbackを呼び出します。仕様かやり方が悪いのかわかりませんが、openしたfile descriptorについて、一度closeしててから、

同一のfile descriptorを再びopenしようとするとLinux,windowsそれぞれでOSエラーがでます。Traceback (most recent call last): File "<stdin>", line 1, in <module> File "/usr/lib/python3.8/os.py", line 1023, in fdopen return io.open(fd, *args, **kwargs) OSError: [Errno 9] Bad file descriptorTraceback (most recent call last): File "<stdin>", line 1, in <module> File "C:\Program Files\WindowsApps\PythonSoftwareFoundation.Python.3.8_3.8.2032.0_x64__qbz5n2kfra8p0\lib\os.py", line 1023, in fdopen return io.open(fd, *args, **kwargs) OSError: [WinError 6] ハンドルが無効です。よって、stdinに使うfile descriptorについては開いたままにしています。

※Popen.communicateについて

サブプロセスへの入力が一度きりの場合については、popenのcommunicateが利用できます。ほかの記事を参考にしてみてください。

- 投稿日:2021-02-25T17:54:34+09:00

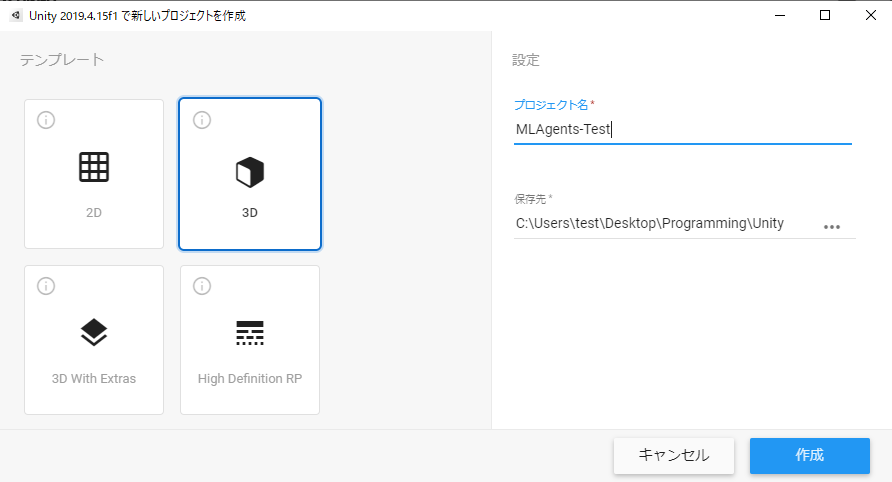

UnityのMLAgentsでPython使って機械学習 2021年最新版

はじめに

こんにちは。陰キャ大学生です。

前置きはさておき、Pythonを使って機械学習していると、「物理エンジン使ってやってみたいなぁ」なんて思う時があります。

ありません

そこで今回は、Unityのために作られた機械学習ライブラリML Agents を使って物理エンジンで機械学習してみました。

実はすでにQiita上には多くのMLAgentsの記事が上がっています。【ML-Agents】UnityとPythonのTensorFlowをつかって機械学習させてみた(v0.11β対応)

しかし、このMLAgents、バージョンアップが頻繁なうえに、バージョン変わると関数やメソッド名も変わるというなんともQiitaライター泣かせな仕様となっています。

そこで今回は、現在(2021年2月25日)最新であるRelease13 について記事を書きます。

おそらく数か月後には古くて使い物にならない記事になると思いますが、今この瞬間にMLAgentsを使いたいんだ!!という人に届いてほしいと思います。MLAgentsについて

こちらの記事が大変わかりやすく参考になりますので、ぜひご覧ください

環境

MLAgentsの推奨環境

- Unity (2018.4以降)

- Python (3.6.1以降)

今回私が使用した環境

- Unity (2019.4.15f1)

- Python (3.7.9) Anaconda

推奨環境を満たしていれば大丈夫だと思いますが、Unityはバージョン等によりUIが変わる可能性があるのでご容赦ください。

前準備

MLAgentsのダウンロード

こちらのサイトから、Release13をダウンロードしてください。

ダウンロードされたZIPファイルを任意の場所に展開してください。PythonとUnityのダウンロード&インストール

参考記事がわかりやすくまとめてくださったので引用します。参照されてください。

【ML-Agents】UnityとPythonのTensorFlowをつかって機械学習させてみた(v0.11β対応)

準備

Pythonの環境構築

Pytorchのインストール

ターミナルで以下を実行します

pip install torch~=1.7.1 -f https://download.pytorch.org/whl/torch_stable.html関連ライブラリのインストール

展開したディレクトリに移動して、以下を実行

pip install -e ./ml-agents-envs pip install -e ./ml-agents実際、

pip install mlagentsでもインストールできますが、この際は常に最新版がインストールされますので、バージョンの整合性をとるためにもダウンロードしたSetup.pyから参照することをお勧めします。0.24.0がインストールされたことを確認してください

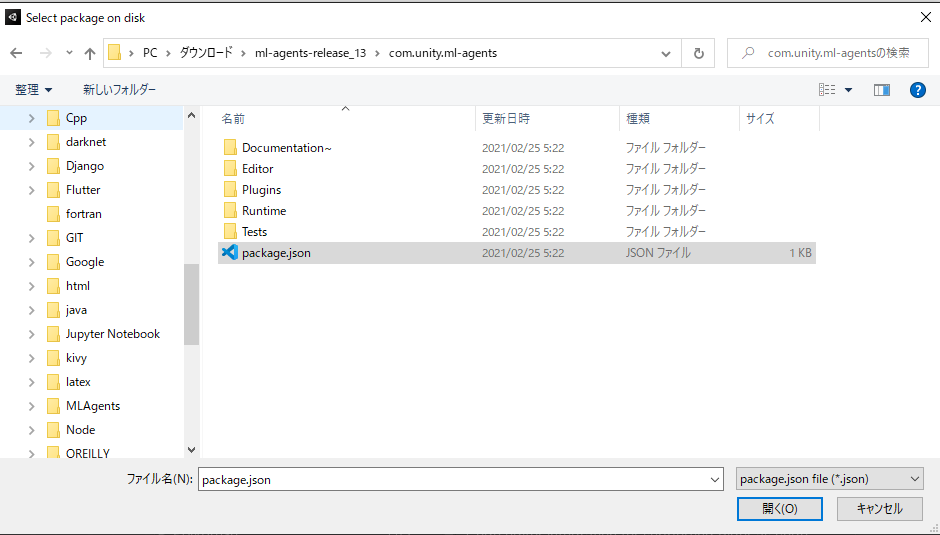

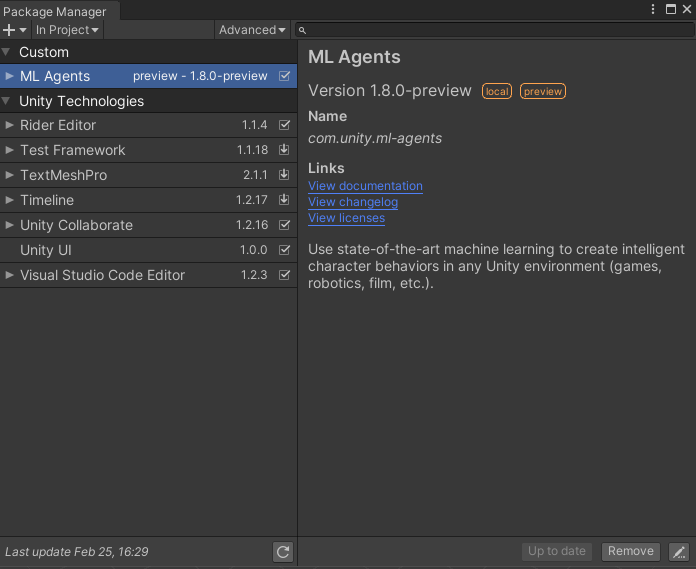

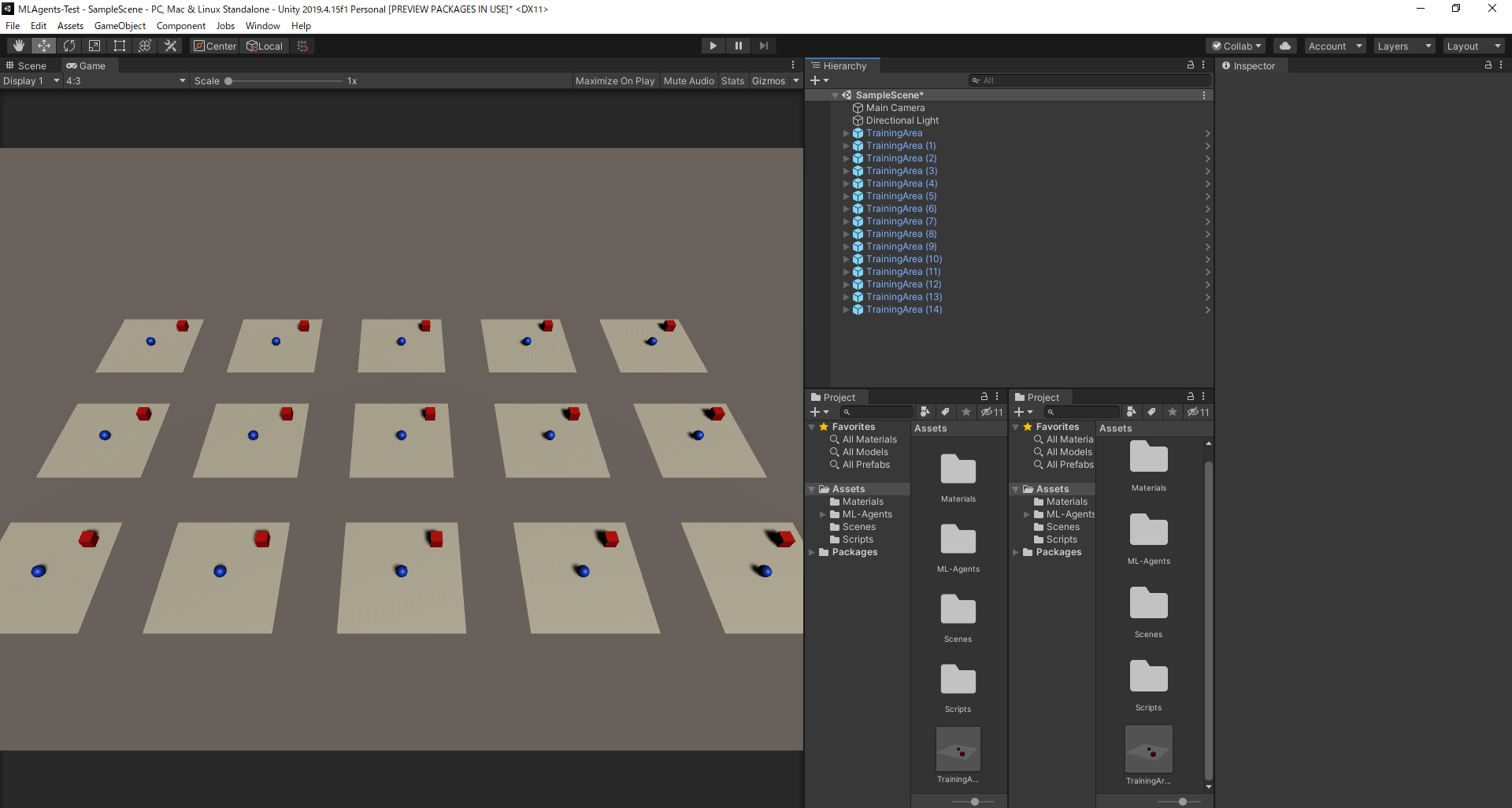

Unitでプロジェクト作成

上のメニューから、

Window>Package Managerの順に進んで、左上の+マークから、Add Package from disk...を選択して、<展開したフォルダ>/com.unity.ml-agents/package.jsonを選択します。

インポートが始まり、

In ProjectにML Agents 1.8.0があれば大丈夫です。

今回は、箱をボールが追いかけるAIを作成します。(詳しくは記事の最後を見てね)

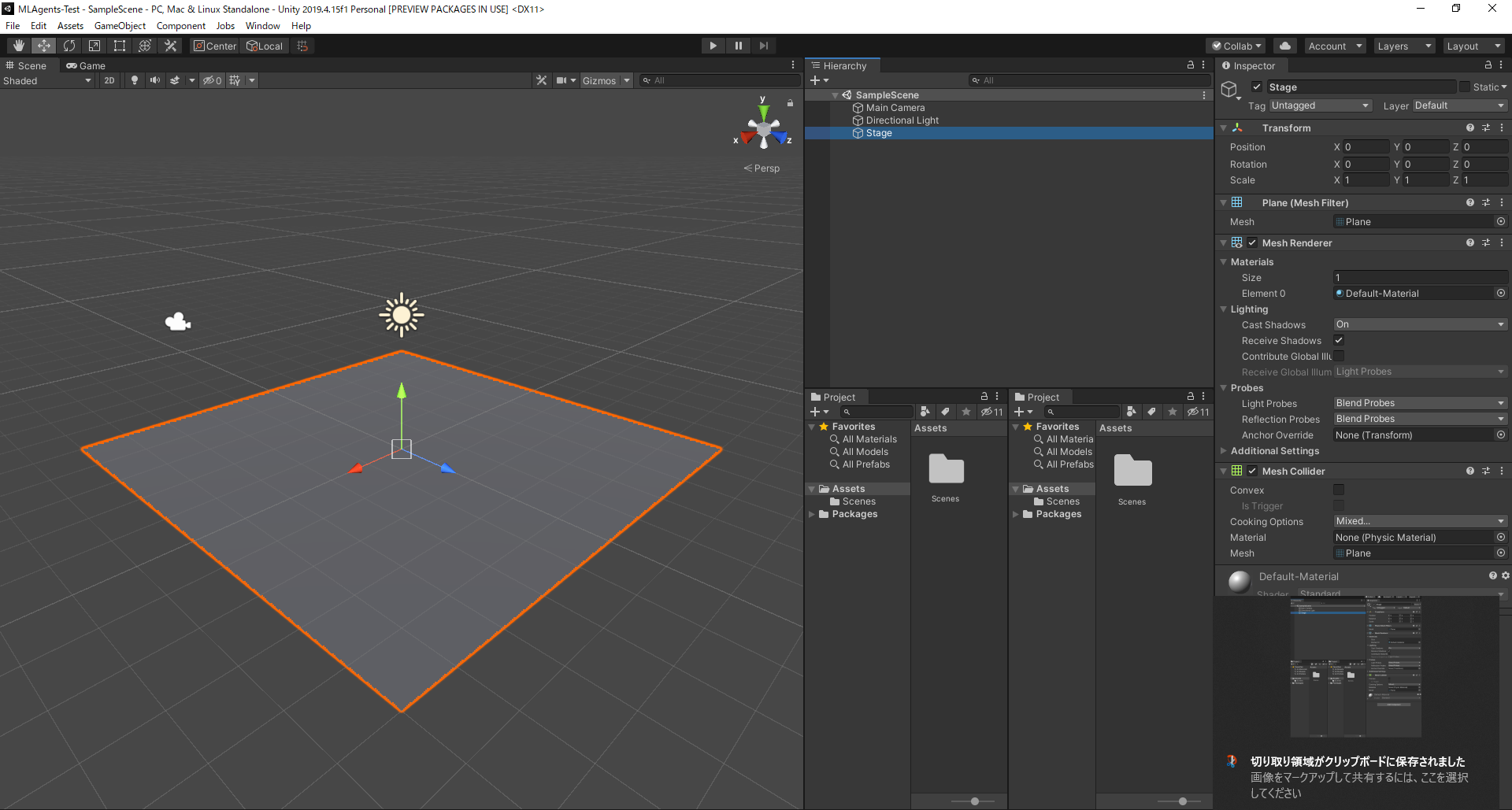

Unityの詳しい説明等はここでは省略します。ステージの作成

GameObject>3D Object>Planeを選択し、Stageに改名、Positionを(0, 0, 0)Scaleを(1, 1, 1)に設定

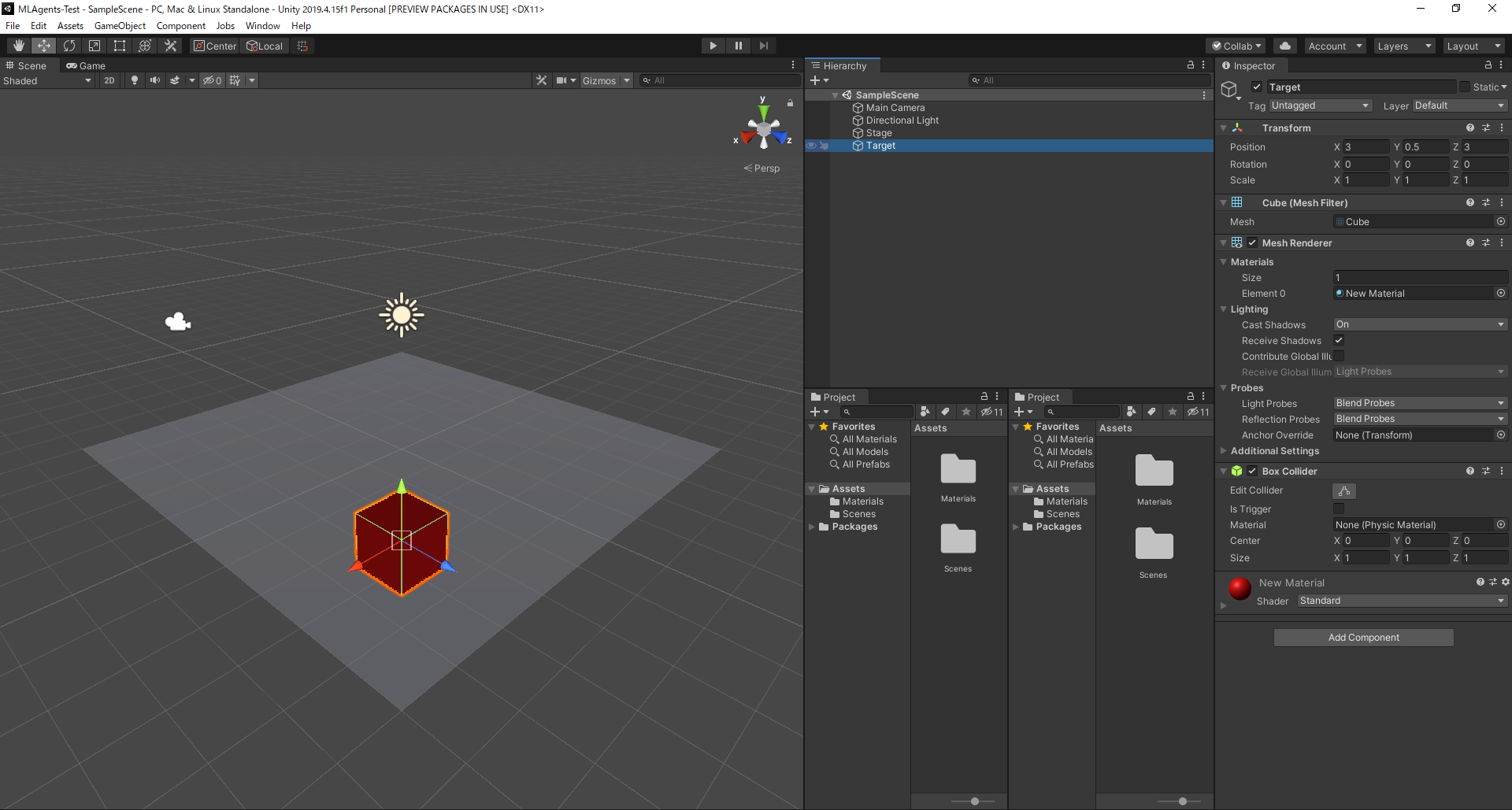

箱の設定

GameObject>3D Object>Cubeを選択し、Targetに改名、Positionを(3, 0.5, 3)Scaleを(1, 1, 1)に設定

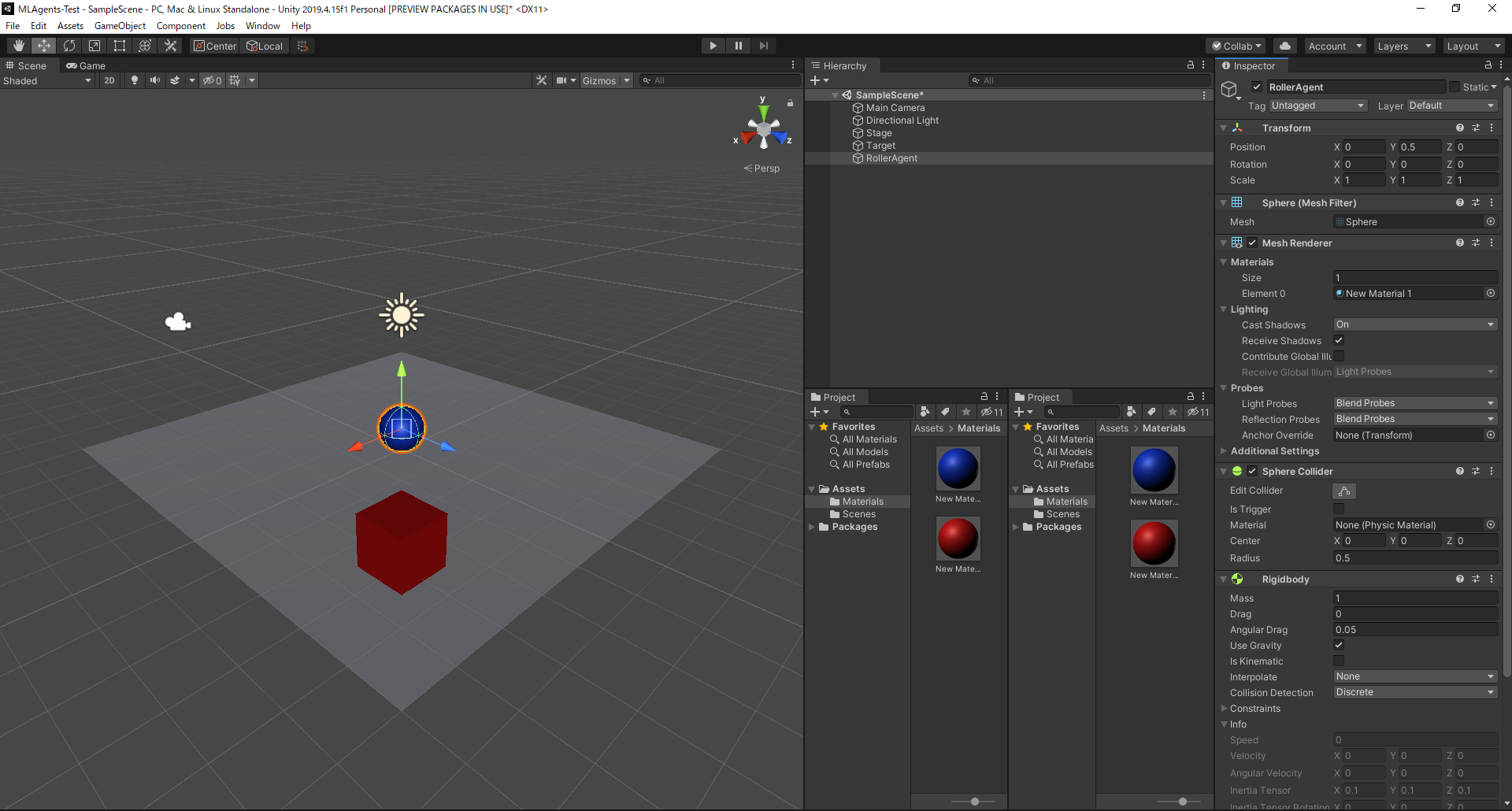

ボールの設定

GameObject>3D Object>Sphereを選択し、RollerAgentに改名、Positionを(0, 0.5, 0)Scaleを(1, 1, 1)に設定Inspector下部の

Add Componentから、Physics>Rigidbodyを追加 ?これめちゃ大事です!!!

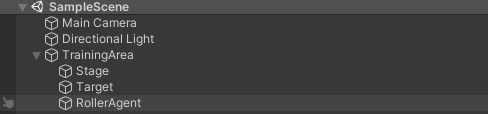

後で複製できるように、グループ化しておきます。

GameObject>Create Emptyを選択し、Stage、Target、RollerAgentをドラッグしてグループ化します名前は何でもいいです。

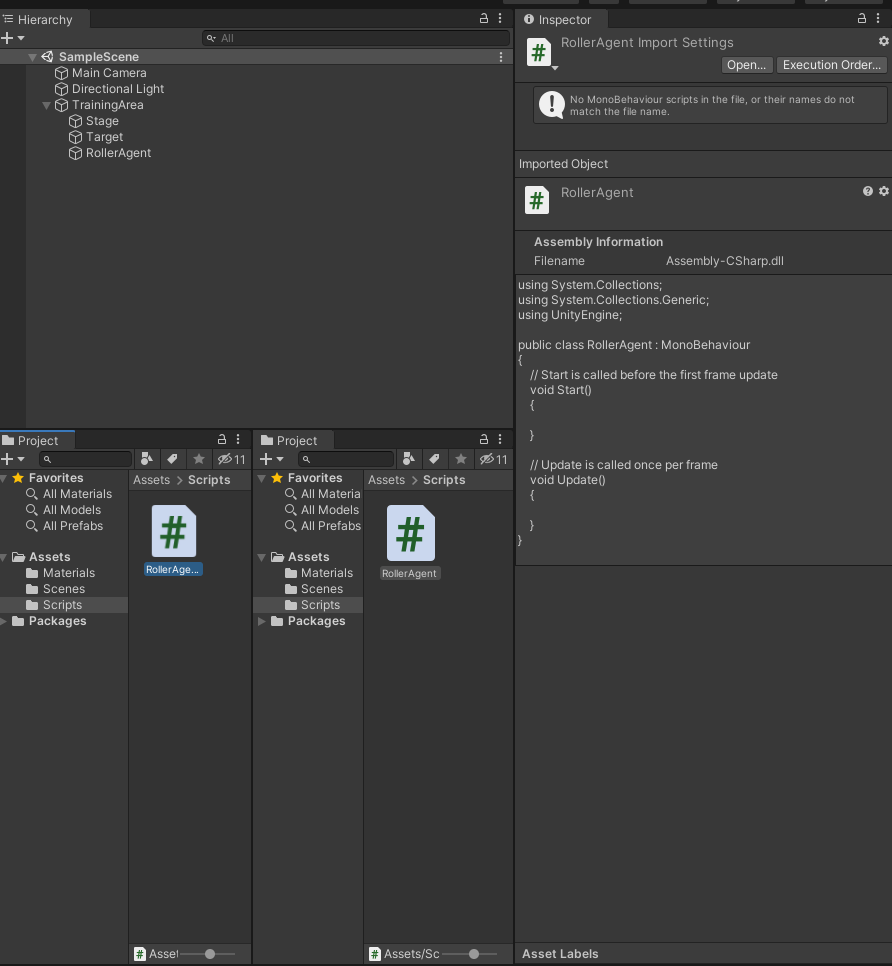

ボールのスクリプト作成

UnityのProject内に

Scriptsフォルダを作り、その中にRollerAgent.csを作成します

中身をお好きなエディタで以下のように書き換えてください。

解説は適宜コメントで挿入してあるので見てみてくださいね。RollerAgent.cs// 使用ライブラリのインポート using System.Collections.Generic; using UnityEngine; using Unity.MLAgents; using Unity.MLAgents.Sensors; using Unity.MLAgents.Actuators; // Agentクラスを継承し、必要なところだけ書き換えていきます public class RollerAgent:Agent { Rigidbody rBody; // スタートしたときに呼び出される関数 void Start () { // ボールの物体を変数に格納 rBody = GetComponent<Rigidbody>(); } // Targetをグローバルに宣言 public Transform Target; // エピソード(学習のステップ)が始まった時に呼び出される関数 public override void OnEpisodeBegin() { // ボールのY座標が0=落下したとき if (this.transform.localPosition.y < 0) { // 初期化 this.rBody.angularVelocity = Vector3.zero; this.rBody.velocity = Vector3.zero; this.transform.localPosition = new Vector3( 0, 0.5f, 0); } // ターゲットをランダムな位置に Target.localPosition = new Vector3(Random.value * 8 - 4, 0.5f, Random.value * 8 - 4); } // 観測データ(この場合で言うと学習に必要な数値)の取得 public override void CollectObservations(VectorSensor sensor) { // ボールと箱の座標(x, y, z) x 2 sensor.AddObservation(Target.localPosition); sensor.AddObservation(this.transform.localPosition); // ボールのスピード(x, z) sensor.AddObservation(rBody.velocity.x); sensor.AddObservation(rBody.velocity.z); // トータルで入力次元は8次元になる } // 力を加えるときの乗数 public float forceMultiplier = 10; // アクションが起きたときに呼び出される関数 public override void OnActionReceived(ActionBuffers actionBuffers) { // XとZ軸の入力に合わせてボールに力を加える Vector3 controlSignal = Vector3.zero; controlSignal.x = actionBuffers.ContinuousActions[0]; controlSignal.z = actionBuffers.ContinuousActions[1]; rBody.AddForce(controlSignal * forceMultiplier); // 箱とボールの距離 float distanceToTarget = Vector3.Distance(this.transform.localPosition, Target.localPosition); // 箱にボールが到達したとき if (distanceToTarget < 1.42f) { // 報酬を1に設定 SetReward(1.0f); // エピソードを終了 EndEpisode(); } // ボールが落下したとき else if (this.transform.localPosition.y < 0) { // エピソードを終了 EndEpisode(); } } // 手で動かす際の設定 public override void Heuristic(in ActionBuffers actionsOut) { var continuousActionsOut = actionsOut.ContinuousActions; continuousActionsOut[0] = Input.GetAxis("Horizontal"); continuousActionsOut[1] = Input.GetAxis("Vertical"); } }ファイルのアタッチ

作成したスクリプトを

RollerAgentにドラッグします。

RollerAgent (Script)のTargetに、Target(ゲームオブジェクト)をドラッグ

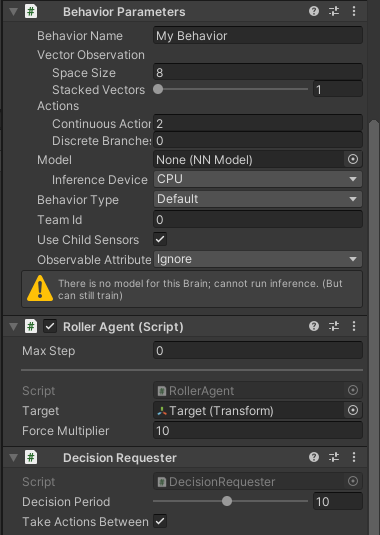

Add Componentから、ML Agents>Behavior Parametersを追加

Vector Observation>Space Sizeを8に変更

Actions>Continuous Actionsを2に変更

Behavior nameをRollerBallに変更

Add Componentから、ML Agents>Decision Requesterを追加

Decision Periodを10に変更テスト

Behavior ParametersのBehavior TypeをHeuristic Onlyに変更中央上部のプレイボタンを押して、矢印キーで遊べるか確認してみてください

学習

<展開したディレクトリ>/config/rollerball.yamlを作成して、以下を書き込みますrollerball.yamlbehaviors: RollerBall: trainer_type: ppo hyperparameters: batch_size: 10 buffer_size: 100 learning_rate: 3.0e-4 beta: 5.0e-4 epsilon: 0.2 lambd: 0.99 num_epoch: 3 learning_rate_schedule: linear network_settings: normalize: false hidden_units: 128 num_layers: 2 reward_signals: extrinsic: gamma: 0.99 strength: 1.0 max_steps: 500000 time_horizon: 64 summary_freq: 1000

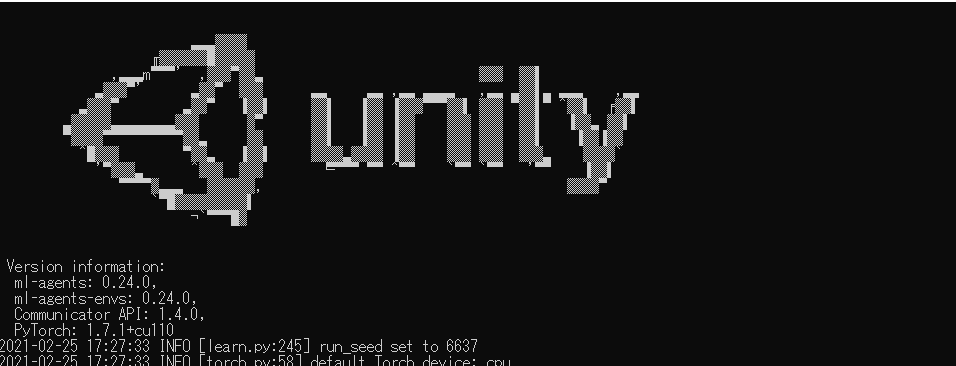

Behavior ParametersのBehavior TypeをDefaultに変更展開したディレクトリに移動して、以下を実行

mlagents-learn config/rollerball.yaml --run-id=RollerBallListening on port 5004. Start training by pressing the Play button in the Unity Editor.この文言がでたら、Unityに戻って、プレイボタンを押すと、学習が始まります。

最初のうちはボールがオロオロ動くのがなかなかに可愛いです笑学習並列化

物理エンジンのいいところは、モデルを複製して同時に学習を進められるところです。

先ほどグループ化したものをプレハブ化し、複製してみましょう。(特にコード等変える必要はありません)

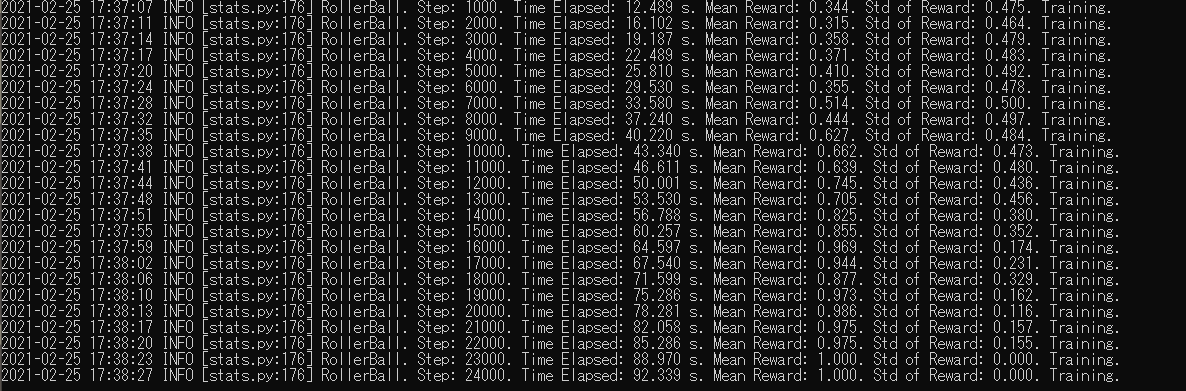

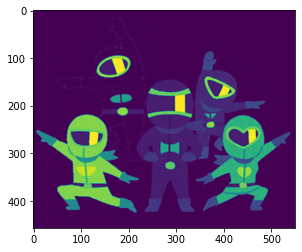

ログはこのようになります。

Mean Rewardが1に近づけばうまく学習が行われています。

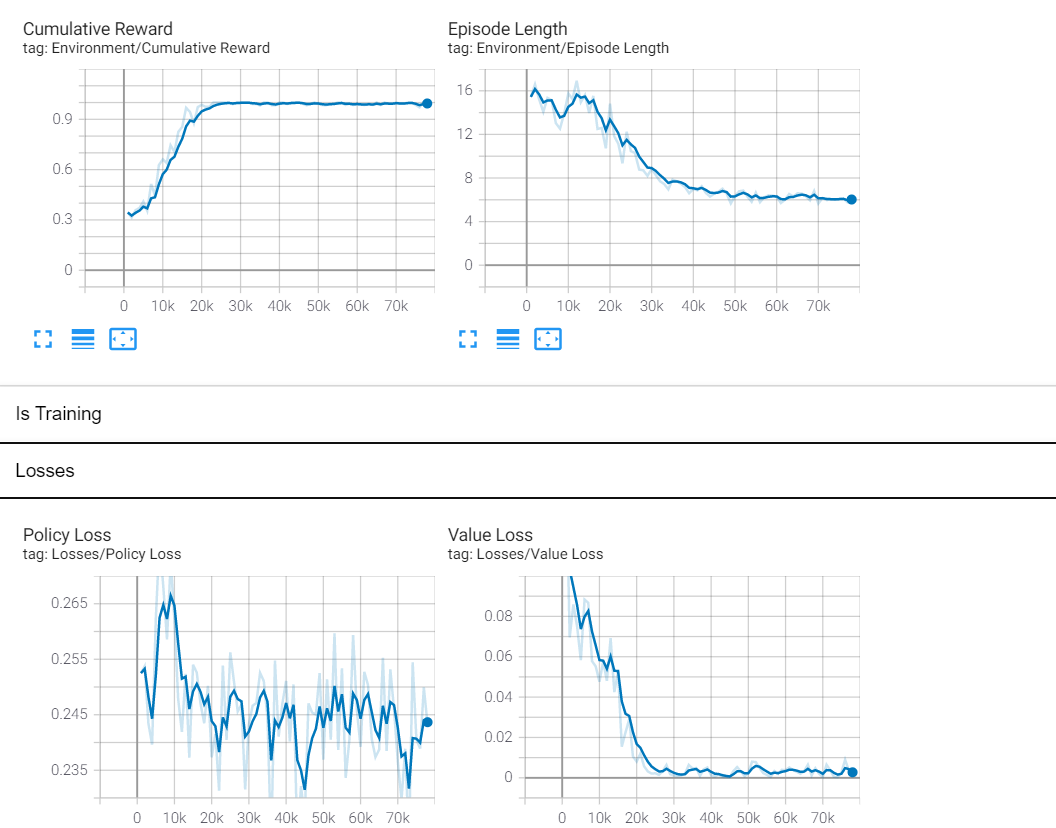

終了したいときは、CTRL+Cで止められます。その時のモデルデータを自動的に保存してくれます。また、バックボーンはTensorFlowなので、別ターミナルでコマンドを実行することで、TensorBoardも確認することができます。

tensorboard --logdir results --port 6006学習モデルでテスト

<展開したディレクトリ>/results/RollerBall/RollerBall.onnxを、Unityプロジェクト内のAssetsにドロップしたのちに、RollerAgentのInspector内ののBehavior Parameters>Modelにドロップ。プレイボタンを押すと、学習されたモデルでボールが動く様子を見ることができます。

床から落ちることなく箱を一生懸命追っている姿が確認できますね。可愛い。最後に

たびたびバージョンの変わってしまうMLAgentsですが、使い方によっては機械学習の世界が広がると思います。

僕も早くコマンドラインで学習できるようにならないかなぁ

- 投稿日:2021-02-25T17:27:03+09:00

Pythonで学ぶ制御工学 第7弾:グラフ作成へ向けて

#Pythonで学ぶ制御工学< グラフ作成へ向けて >

はじめに

基本的な制御工学をPythonで実装し,復習も兼ねて制御工学への理解をより深めることが目的である.

その第7弾として「グラフ作成へ向けて」を扱う.グラフ作成へ向けて

ここでは,次回以降必要になってくるグラフ作成において,便利になってくるであろうものを関数化し,以降使えるようにする.関数化することで,毎度細かな設定を行う手間が省ける.なお,ここで記述するのは,参考書にあったものであり,絶対的なものではない.あくまでもその参考書の説明の中で手間を省くために用意されているものである.しかしながら,設定の方法を学ぶことができ,今後自分好みや,ある基準に従った仕様でグラフ作成する際に,役立つ知識となるであろうと思い,ここに記録することとする.

関数の定義

for_plot.py""" 2021/02/25 @Yuya Shimizu 図を整えるための関数定義 """ #グラフをプロットするときの線種を決めるジェネレータ def linestyle_generator(): linestyle = ['-', '--', '-.', ':'] lineID = 0 while True: yield linestyle[lineID] lineID = (lineID + 1) % len(linestyle) #グラフを整える関数 def plot_set(fig_ax, *args): fig_ax.set_xlabel(arg[0]) #x軸のラベルを1つ目の引数で設定 fig_ax.set_ylabel(arg[1]) #y軸のラベルを2つ目の引数で設定 fig_ax.grid(ls=':') #グラフの補助線を点線で設定 if len(args) == 3: fig_ax.legend(loc=args[2]) #凡例の位置を3つ目の引数で設定 #ボード線図を整える関数 def bodeplot_set(): #ゲイン線図のグリッドとy軸ラベルの設定 fig_ax[0].grid(which='both', ls=':') fig_ax[0].set_ylabel('Gain [dB]') #位相線図のグリッドとx軸, y軸ラベルの設定 fig_ax[1].grid(which='both', ls=':') fig_ax[1].set_xlabel('$\omega$ [rad/s]') fig_ax[1].set_ylabel('Phase [deg]') #凡例の表示 if len(args) > 0: fig_ax[1].legend(loc=args[0]) #引数が1つ以上:ゲイン線図に表示 if len(args) > 1: fig_ax[0].legend(loc=args[1]) #引数が2つ以上:位相線図にも表示感想

今回は直接制御工学についての学習ではなかったが,グラフをきれいに整えるものを関数化するというのは,この教材にとどまらず,以降,何かしらグラフを扱っていく中で役立つことにはなってくるはずである.

参考文献

Pyhtonによる制御工学入門 南 祐樹 著 オーム社

- 投稿日:2021-02-25T16:28:28+09:00

VSCodeで、「ターミナルの起動に失敗しました。エラー 1260」でPythonが実行できない。

さて、VSCodeでPythonを使う方法は、色々ウェブ上で紹介されていますが、基本的にインストーラを使えば、パスの設定などは必要ないはずだと思います。

ところが、私の場合、Windows10でVSCodeのインストール → Pythonのインストール → print("Hello world!")を実行、と行けるはずが、print文を実行して、「ターミナルの起動に失敗しました。エラー 1260」で、右下にターミナル・ウィンドウが表示されませんでした。

そこで、VSCodeを一度アンインストールし、再インストールしたのですが、ダメでした。

さらに、設定 → 機能 → ターミナル を確認し、

External: Windows Exec

どのターミナルを Windows で実行するかをカスタマイズします。

C:\WINDOWS\System32\cmd.exe

と正しく設定されていました。そこで、このエラーメッセージ上にあったトラブルシューティングをよく読み、

C:\Users(ユーザ名)\AppData\Roaming\Code\User\ にある settings.json に、

"terminal.integrated.shell.windows": "C:\\WINDOWS\\system32\\cmd.exe"

の1行を手動で追加して、Pythonが無事動きました。何かの参考になれば、幸いです。

以上です。

- 投稿日:2021-02-25T16:22:48+09:00

ポケモンセンターオンラインの入荷情報をLINEbotを使用して通知する