- 投稿日:2019-02-09T23:23:31+09:00

【Python】特定のインスタンスにメソッドを追加

types.MethodTypeを使うtypes.MethodType(function, instance) Create a bound instance method object.バウンドされたインスタンスメソッドを作成します

動作環境

Python 3.7.1特定のインスタンスにだけメソッドを追加する

class MyClass: def __init__(self, name): self._name = name a = MyClass('tamago') b = MyClass('taro')

bのインスタンスにだけメソッドを追加したい場合、types.MethodType()でbに紐づくインスタンスメソッド(get_name)を生成し、b.get_nameに設定する# 関数を定義 >>> def get_name(self): ... return self._name >>> import types # bのインスタンスメソッドを生成し、設定する >>> b.get_name = types.MethodType(get_name, b) >>> b.get_name() 'taro'また、

aにはget_nameというメソッドは無いため、エラーになる>>> a.get_name() Traceback (most recent call last): File "<stdin>", line 1, in <module> AttributeError: 'MyClass' object has no attribute 'get_name' 'MyClass' object has no attribute 'get_name'面白い

参考文献

- 投稿日:2019-02-09T23:14:00+09:00

数字と文字

前回:https://qiita.com/New_enpitsu_15/items/b71c7da6387b315d6f7e

次回:

目次:https://qiita.com/New_enpitsu_15/private/479c69897780cabd01f4Pythonには、というか、ほとんどのプログラム言語には数字と文字の区別があります。

数字と文字の区別?

前回、

文字列という単語が出てきたのを覚えていますか?

文字列は、その名の通り文字の集合です。文字は文字じゃん…と言われれば、文字は文字なのですが

たとえば

1+1

は2ですよね?

ところがどっこい。"1"+"1"

は"11"なのです。

そんな小学生のひっかけみたいなこと…と思うかもしれませんが、実際にprint(1+1) #2 print("1"+"1") #11と実行してあげるとそうなるのです。

これは

1は数値を表していて、

"1"は文字を表しているから。だいたいイメージはつくとは思いますが、

文字列("1"とか)同士の足し算は結合ってことになります。

なので"1"と"1"を結合したら"11"なんですね。1+1はそのまま数値の計算ですから2です。

数字と文字の区別は、そういったところから必要となってくるんですね。

ちょっとまって!"や'を文字として使いたいんだけど!

普通では、

"と'は文字を区別するための記号なので使うことはできません。でも

"+"と表示したかったりするときはどうすればいいの?大丈夫。そんな時は、

'"+"'と、周りを違う引用符で囲ってあげましょう。print('"+"') #"+"せんせー!だったら'"+"'は表示できないんですかー?

できます。

でもこれは少し厄介。普通に"で囲っても、''と表示されるだけでしょう。print("'"+"'")#"'"と"'"を結合している #''だったらどうするの。そんな時はバックスラッシュ(えんまーく)を文字として表示したい

"の前につけてあげましょう。print("'\"+\"'") #'"+"'すると、

'"+"'と表示されましたね。

この、文字の前につけるバックスラッシュのことを、エスケープシークエンスといったりします。エスケープ

エスケープは

"の前に\と書きましたが、他にもいろいろあります。

例えば、\'は'を文字として。\\は\自体を文字として表示してくれます。print("\"") #" print('\'') #' print("\\") #\ほかにも、

\nで改行。print("ここで日記は途切れている\n\n\nとでも思っていたのか") #日記はここで途切れている # # # #とでも思っていたのかなどなど、ほかにもいろいろな種類があります。

(調べるときは「Python エスケープ」等で)

次回は

変数についてやりますよ~

なんでprint(aaa)だとaaaと表示されずにエラーなの?

そんな謎を解明。

- 投稿日:2019-02-09T23:09:43+09:00

Pythonでe-statにAPIアクセスしてSQLServerに突っ込むときにJSONとPandasで格闘したメモ

はじめに

興味深いAPI

[2019] 公開されているAPI一覧まとめ

Netflix API | ProgrammableWeb

BloombergのAPIから価格取得をするジェイソンとデータフレーム

最初に e-stat からデータを取ろうとしたときに、jsonでの取得まではすんなりいったけど、データフレームの入れ方が悪かった(JSONとデータフレームの関係がわかってなかった)ということがあった。

Syntax(構文)

pandas.read_json

Convert a JSON string to pandas object.構文についてpandas.read_json(path_or_buf=None, orient=None)引数についてpath_or_buf : a valid JSON string or file-like, default: None orient : string, 'records' : list like [{column -> value}, ... , {column -> value}]返り値についてresult : Series or DataFrame, depending on the value of typ.JSON試行錯誤

こんな感じに書いて...import urllib import urllib.request import pandas as pd # Read appId with open('api_setting/appid.txt', mode='r', encoding='utf-8') as f: appId = f.read() # stat url url = r'http://api.e-stat.go.jp/rest/2.1/app/json/getStatsData?' # Query param setting keys = { "appId" : appId, "lang" : "J" , "statsDataId" : "0003143513" , "metaGetFlg" : "Y" , "cntGetFlg" : "N", "sectionHeaderFlg" : "1" } # Get json data query_param = urllib.parse.urlencode(keys) df = pd.read_json(urllib.request.urlopen(url + query_param).read(), orient='records') print(df)Pythonコンソール(こんなふうに出てきたので)>>> df GET_STATS_DATA PARAMETER {'LANG': 'J', 'STATS_DATA_ID': '0003143513', '... RESULT {'STATUS': 0, 'ERROR_MSG': '正常に終了しました。', 'DATE... STATISTICAL_DATA {'RESULT_INF': {'TOTAL_NUMBER': 13142278, 'FRO...Pythonコンソール(データを取る練習してたんだけど)------------- データフレームてっぺんから最下層のリテラルを取るぞ! ------------- >>> print(df.columns) Index(['GET_STATS_DATA'], dtype='object') >>> print(df['GET_STATS_DATA']) PARAMETER {'LANG': 'J', 'STATS_DATA_ID': '0003143513', '... RESULT {'STATUS': 0, 'ERROR_MSG': '正常に終了しました。', 'DATE... STATISTICAL_DATA {'RESULT_INF': {'TOTAL_NUMBER': 13142278, 'FRO... >>> print(df['GET_STATS_DATA']['RESULT']) {'STATUS': 0, 'ERROR_MSG': '正常に終了しました。', 'DATE': '2019-02-07T22:35:18.179+09:00'} # ここまでで、1つの固有値を取得できた >>> print(df['GET_STATS_DATA']['RESULT']['ERROR_MSG']) 正常に終了しました。Pythonコンソール(データフレームのまま、APIデータまでたどり着けない!)------------- Pandasで集計するぞ! ------------- # あれ、一段下がっただけでシリーズになっちまうのか...まぁそうか >>> print(type(df['GET_STATS_DATA'])) <class 'pandas.core.series.Series'> # ここから下は辞書になっちまうのか... >>> print(type(df['GET_STATS_DATA']['STATISTICAL_DATA'])) <class 'dict'> >>> print(df['GET_STATS_DATA']['STATISTICAL_DATA']['DATA_INF'].keys()) dict_keys(['NOTE', 'VALUE']) ???? >>> print(df['GET_STATS_DATA']['STATISTICAL_DATA']['DATA_INF']['VALUE']) (・3・)アルェー?とにかくデータフレームのまま操作したいのにできない。というハマりポイントがあった。ただこれ整理してみると、JSONデータであればデータフレームの入れ物にはスポッと入ってくれる。ただ、jsonの最初には大概ヘッダが入っている。つまり、データフレームに入れる時点で十分に階層を降りていないといけないということがわかった。

https://dev.classmethod.jp/etc/concrete-example-of-json/JSONデータの例(あーなるほど、たしかにヘッダが入ってるわ...)[ { "InstanceId": "i-XXXXXXXX", "ImageId": "ami-YYYYYYYY", "LaunchTime": "2015-05-28T08:30:10.000Z", "Tags": [ { "Value": "portnoydev-emr", "Key": "Name" }, { "Value": "j-ZZZZZZZZZZZZ", "Key": "aws:elasticmapreduce:job-flow-id" }, { "Value": "CORE", "Key": "aws:elasticmapreduce:instance-group-role" } ] }, (略) ]Pythonコンソール(なのでデータフレームに入れるのはJSONナマじゃなくて...)>>> df = pd.read_json(urllib.request.urlopen(url + query_param).read(), orient='records')Pythonコンソール(こうなんやな!)>>> df = pd.read_json(urllib.request.urlopen(url + query_param).read(), orient='records')['GET_STATS_DATA']['STATISTICAL_DATA'] >>> print(type(df)) <class 'dict'> (・3・)アルェー?Pythonコンソール(オライリーを見てみると、辞書をデータフレームに変換してた)>>> print(type(result['GET_STATS_DATA']['STATISTICAL_DATA'])) <class 'dict'> >>> stats = pd.DataFrame(result['GET_STATS_DATA']['STATISTICAL_DATA']) >>> print(type(stats)) <class 'pandas.core.frame.DataFrame'> >>> stats RESULT_INF ... DATA_INF @id NaN ... NaN CLASS_OBJ NaN ... NaN CYCLE NaN ... NaN FROM_NUMBER 1.0 ... NaN GOV_ORG NaN ... NaN MAIN_CATEGORY NaN ... NaN NEXT_KEY 100001.0 ... NaN NOTE NaN ... {'@char': '***', '$': '該当データがない場合を示す。'} OPEN_DATE NaN ... NaN OVERALL_TOTAL_NUMBER NaN ... NaN SMALL_AREA NaN ... NaN STATISTICS_NAME NaN ... NaN STATISTICS_NAME_SPEC NaN ... NaN STAT_NAME NaN ... NaN SUB_CATEGORY NaN ... NaN SURVEY_DATE NaN ... NaN TITLE NaN ... NaN TITLE_SPEC NaN ... NaN TOTAL_NUMBER 13142278.0 ... NaN TO_NUMBER 100000.0 ... NaN UPDATED_DATE NaN ... NaN VALUE NaN ... [{'@tab': '1', '@cat01': '0001', '@area': '13A... [22 rows x 4 columns]Pythonコンソール(VALUEまで取りに行けばいいじゃん?...ダメらしい...)>>> stats = pd.DataFrame(result['GET_STATS_DATA']['STATISTICAL_DATA']['VALUE']) Traceback (most recent call last): File "<stdin>", line 1, in <module> KeyError: 'VALUE'たしかにそこにいるはずなんだが...

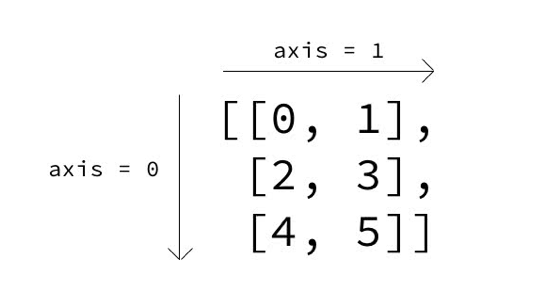

なんかもう昔のゲームやってるみたいだわ、3次元以上の配列って...(この感じわかるひといる?)

ん?

Pythonコンソール(なるほど?いままでの単純な表形式の見方を発展させないといけないか)>>> stats.columns Index(['RESULT_INF', 'TABLE_INF', 'CLASS_INF', 'DATA_INF'], dtype='object') >>> stats['DATA_INF'] @id NaN CLASS_OBJ NaN CYCLE NaN FROM_NUMBER NaN GOV_ORG NaN MAIN_CATEGORY NaN NEXT_KEY NaN NOTE {'@char': '***', '$': '該当データがない場合を示す。'} OPEN_DATE NaN OVERALL_TOTAL_NUMBER NaN SMALL_AREA NaN STATISTICS_NAME NaN STATISTICS_NAME_SPEC NaN STAT_NAME NaN SUB_CATEGORY NaN SURVEY_DATE NaN TITLE NaN TITLE_SPEC NaN TOTAL_NUMBER NaN TO_NUMBER NaN UPDATED_DATE NaN VALUE [{'@tab': '1', '@cat01': '0001', '@area': '13A... Name: DATA_INF, dtype: object # これやるとデータがずばーっと出てくるので >>> stats['DATA_INF']['VALUE'] # 5レコードにおさえる >>> stats['DATA_INF']['VALUE'][0:5] [{'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2019000101', '$': '101.2'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018001212', '$': '101.2'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018001111', '$': '101.4'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018001010', '$': '101.7'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018000909', '$': '101.4'}]5レコードのJSONを整理する>>> stats['DATA_INF']['VALUE'][0:5] [ {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2019000101', '$': '101.2'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018001212', '$': '101.2'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018001111', '$': '101.4'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018001010', '$': '101.7'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018000909', '$': '101.4'} ]Pythonコンソール(listかぁ...これもういっちょデータフレームにキャストしてみるか)>>> print(type(stats['DATA_INF']['VALUE'])) <class 'list'> # あっ!なんかキタぞ!めっちゃ試行錯誤いるなぁ...JSON... >>> df = pd.DataFrame(stats['DATA_INF']['VALUE']) >>> df $ @area @cat01 @tab @time 0 101.2 13A01 0001 1 2019000101 1 101.2 13A01 0001 1 2018001212 2 101.4 13A01 0001 1 2018001111 3 101.7 13A01 0001 1 2018001010 4 101.4 13A01 0001 1 2018000909 ... ... ... ... ... ... 99995 100.9 00049 0003 1 2011000808 99996 100.8 00049 0003 1 2011000707 99997 99.6 00049 0003 1 2011000606 99998 99.9 00049 0003 1 2011000505 99999 99.4 00049 0003 1 2011000404 [100000 rows x 5 columns] >>> df['$'] 0 101.2 1 101.2 2 101.4 3 101.7 4 101.4 ... 99995 100.9 99996 100.8 99997 99.6 99998 99.9 99999 99.4 Name: $, Length: 100000, dtype: object >>> df['@time'] 0 2019000101 1 2018001212 2 2018001111 3 2018001010 4 2018000909 ... 99995 2011000808 99996 2011000707 99997 2011000606 99998 2011000505 99999 2011000404 Name: @time, Length: 100000, dtype: object補足:見てるオライリーはこれ

オライリーって無骨だけど読みやすいよね

JSONコンソール操作まとめ

res(=Full JSON) が返ってきてから、dfに入れる直前までの間に、単純なタテヨコの一般的な(?)2元配列になるところまで十分にJSON配列(?)を潜ってからデータフレームに渡すんや。...というよりは、dfに代入してデータフレーム手に入ったー!って思ってたのはただのナマJSONだった(pd.DataFrame(...)の漏れ)

Pythonコンソール>>> import urllib >>> import urllib.request >>> import pandas as pd >>> appId = '****************************' >>> url = r'http://api.e-stat.go.jp/rest/2.1/app/json/getStatsData?' >>> keys = { "appId" : appId, "lang" : "J" , "statsDataId" : "0003143513" , "metaGetFlg" : "Y" , "cntGetFlg" : "N", "sectionHeaderFlg" : "1" } >>> query_param = urllib.parse.urlencode(keys) >>> res = pd.read_json(urllib.request.urlopen(url + query_param).read(), orient='records') >>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['DATA_INF']['VALUE']) >>> df $ @area @cat01 @tab @time 0 101.2 13A01 0001 1 2019000101 1 101.2 13A01 0001 1 2018001212 2 101.4 13A01 0001 1 2018001111 3 101.7 13A01 0001 1 2018001010 4 101.4 13A01 0001 1 2018000909 ... ... ... ... ... ... 99995 100.9 00049 0003 1 2011000808 99996 100.8 00049 0003 1 2011000707 99997 99.6 00049 0003 1 2011000606 99998 99.9 00049 0003 1 2011000505 99999 99.4 00049 0003 1 2011000404 [100000 rows x 5 columns] >>> df['$'] 0 101.2 1 101.2 2 101.4 3 101.7 4 101.4 ... 99995 100.9 99996 100.8 99997 99.6 99998 99.9 99999 99.4 Name: $, Length: 100000, dtype: object >>> df['@time'] 0 2019000101 1 2018001212 2 2018001111 3 2018001010 4 2018000909 ... 99995 2011000808 99996 2011000707 99997 2011000606 99998 2011000505 99999 2011000404 Name: @time, Length: 100000, dtype: object

ようやく僕が知ってるデータフレームまできたぁ~

いっかい寝よ...つべこべいわずにJSON整形サイトに流し込め!

http://tm-webtools.com/Tools/JsonBeauty

元のデータを知らない(作ってない)んだから試行錯誤になるのはあたりまえ!あっ!階層一撃で追えるわ...トホホ{ "GET_STATS_DATA": { "RESULT": { "STATUS": 0, "ERROR_MSG": "正常に終了しました。", "DATE": "2019-02-08T21:16:05.801+09:00" }, "PARAMETER": { "LANG": "J", "STATS_DATA_ID": "0003143513", "DATA_FORMAT": "J", "START_POSITION": 1, "METAGET_FLG": "Y", "CNT_GET_FLG": "N", "SECTION_HEADER_FLG": 1 }, "STATISTICAL_DATA": { "RESULT_INF": { "TOTAL_NUMBER": 13142278, "FROM_NUMBER": 1, "TO_NUMBER": 100000, "NEXT_KEY": 100001 }, "TABLE_INF": { "@id": "0003143513", "STAT_NAME": { "@code": "00200573", "$": "消費者物価指数" }, "GOV_ORG": { "@code": "00200", "$": "総務省" }, "STATISTICS_NAME": "2015年基準消費者物価指数", "TITLE": { "@no": "1", "$": "消費者物価指数(2015年基準)" }, "CYCLE": "-", "SURVEY_DATE": 0, "OPEN_DATE": "2019-01-25", "SMALL_AREA": 0, "MAIN_CATEGORY": { "@code": "07", "$": "企業・家計・経済" }, "SUB_CATEGORY": { "@code": "03", "$": "物価" }, "OVERALL_TOTAL_NUMBER": 13142278, "UPDATED_DATE": "2019-01-24", "STATISTICS_NAME_SPEC": { "TABULATION_CATEGORY": "2015年基準消費者物価指数" }, "TITLE_SPEC": { "TABLE_NAME": "消費者物価指数(2015年基準)" } }, "CLASS_INF": { "CLASS_OBJ": [ { "@id": "tab", "@name": "表章項目", "CLASS": [ { "@code": "1", "@name": "指数", "@level": "" }, { "@code": "2", "@name": "前月比・前年比・前年度比", "@level": "", "@unit": "%" }, { "@code": "3", "@name": "前年同月比", "@level": "", "@unit": "%" }, { "@code": "4", "@name": "ウエイト(実数)", "@level": "" }, { "@code": "5", "@name": "ウエイト(万分比)", "@level": "" } ] }, { "@id": "cat01", "@name": "2015年基準品目", "CLASS": [ { "@code": "0001", "@name": "0001 総合", "@level": "1" }, { "@code": "0002", "@name": "0002 食料", "@level": "1" }, { "@code": "0003", "@name": "0003 穀類", "@level": "3", "@parentCode": "0002" }, (略) ] } ] }, "DATA_INF": { "NOTE": { "@char": "***", "$": "該当データがない場合を示す。" }, "VALUE": [ { "@tab": "1", "@cat01": "0001", "@area": "13A01", "@time": "2019000101", "$": "101.2" }, { "@tab": "1", "@cat01": "0001", "@area": "13A01", "@time": "2018001212", "$": "101.2" }, { "@tab": "1", "@cat01": "0001", "@area": "13A01", "@time": "2018001111", "$": "101.4" }, (略) ] } } } }e-Stat

(JSONの試行錯誤は上のセクションにまとめたので、それ以外を書きます)

参考ページ

e-Stat(政府統計)のAPI機能をつかってpythonでグラフを書いたりしてみる

APIの使い方 how_to_use前準備情報等

・ユーザー登録

・ログインしてマイページ→API機能(アプリケーションID発行)

・名称は「開発用」

・URLは「ttp://localhost/」(※Qiitaだとリンクになっちゃうから先頭の h は削除)

消費者物価指数 2015年基準消費者物価指数(公開日:2019-01-25)

消費者物価指数(URLをよく見ると「appId」に何も入っていない)(使い方を見て、jsonで表示するように加工してある)http://api.e-stat.go.jp/rest/2.1/app/json/getStatsData?appId=&lang=J&statsDataId=0003143513&metaGetFlg=Y&cntGetFlg=N§ionHeaderFlg=1データについて

db形式で表示されるページがあるなら先に構造を見ておけってのは、まぁあたりまえっちゃあたりまえだったね

このへんかな?

https://www.e-stat.go.jp/api/api-info/e-stat-manual#api_3_4うーん?cdArea 地域事項? lvCat01 分類事項01? cdTab 表章事項? lvTime 時間軸事項?VALUE 統計数値(セル)の情報です。データ件数分だけ出力されます。

属性として表章事項コード(tab)、分類事項コード(cat01 ~ cat15)、地域事項コード(area)、時間軸事項コード(time)、単位(unit)を保持します。全ての属性はデータがある場合のみ出力されます。単語:表章 https://www.stat.go.jp/data/kokusei/2010/users-g/pdf/mikata.pdf

うーん、例えば地域コード 13A01 はどこだよ!?マスタは?みたいな感じになるよなぁ~??

Pythonコンソール>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['DATA_INF']['VALUE']) >>> df $ @area @cat01 @tab @time 0 101.2 13A01 0001 1 2019000101 1 101.2 13A01 0001 1 2018001212 2 101.4 13A01 0001 1 2018001111 3 101.7 13A01 0001 1 2018001010 4 101.4 13A01 0001 1 2018000909 ... ... ... ... ... ... 99995 100.9 00049 0003 1 2011000808 99996 100.8 00049 0003 1 2011000707 99997 99.6 00049 0003 1 2011000606 99998 99.9 00049 0003 1 2011000505 99999 99.4 00049 0003 1 2011000404 [100000 rows x 5 columns]Pythonコンソール(あっ!わかった!同じJSONに入ってるぞ!CLASS_INFだ)>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ']) >>> df @id @name CLASS 0 tab 表章項目 [{'@code': '1', '@name': '指数', '@level': ''}, ... 1 cat01 2015年基準品目 [{'@code': '0001', '@name': '0001 総合', '@level... 2 area 地域(2015年基準) [{'@code': '13A01', '@name': '13100 東京都区部', '@... 3 time 時間軸(年・月) [{'@code': '2019000101', '@name': '2019年1月', '...整形サイト http://tm-webtools.com/Tools/JsonBeauty でJSONとにらめっこだな。

わかってきたのは...Pythonコンソール>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][0]['CLASS']) >>> df @code @level @name @unit 0 1 指数 NaN 1 2 前月比・前年比・前年度比 % 2 3 前年同月比 % 3 4 ウエイト(実数) NaN 4 5 ウエイト(万分比) NaNPythonコンソール>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][1]['CLASS']) >>> df @code @level @name @parentCode 0 0001 1 0001 総合 NaN 1 0002 1 0002 食料 NaN 2 0003 3 0003 穀類 0002 3 0004 5 0004 米類 0003 4 1000 6 1000 うるち米 0004 .. ... ... ... ... 793 0905 1 0905 食料(酒類を除く)及びエネルギーを除く総合(季節調整済) NaN 794 0921 1 0921 財(季節調整済) NaN 795 0922 1 0922 半耐久消費財(季節調整済) NaN 796 0923 1 0923 生鮮食品を除く財(季節調整済) NaN 797 0906 1 0906 生鮮食品及びエネルギーを除く総合(季節調整済) NaN [798 rows x 4 columns]Pythonコンソール>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][2]['CLASS']) >>> df @code @level @name 0 13A01 1 13100 東京都区部 1 00000 1 全国 2 00011 1 人口5万以上の市 3 00012 1 大都市 4 00013 1 中都市 .. ... ... ... 67 14A02 1 14130 川崎市 68 14A03 1 14150 相模原市 69 22A02 1 22130 浜松市 70 27A02 1 27140 堺市 71 40A01 1 40100 北九州市 [72 rows x 3 columns]Pythonコンソール>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][3]['CLASS']) >>> df @code @level @name @parentCode 0 2019000101 4 2019年1月 2019000103 1 2018001212 4 2018年12月 2018001012 2 2018001111 4 2018年11月 2018001012 3 2018001010 4 2018年10月 2018001012 4 2018000909 4 2018年9月 2018000709 .. ... ... ... ... 681 1970000404 4 1970年4月 1970000000 682 1970000303 4 1970年3月 1970000000 683 1970000202 4 1970年2月 1970000000 684 1970000101 4 1970年1月 1970000000 685 1970000000 1 1970年 NaN [686 rows x 4 columns]つまり...どういうことだってばよ

データフレームに SQL:Where を適用する

https://pandas.pydata.org/pandas-docs/stable/reference/api/pandas.DataFrame.where.html

まぁ4つのマスタはそれぞれ違うデータフレームに受け取るのがわかりやすいとは思うけどPythonコンソール(この明細を例にとったときに...)>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['DATA_INF']['VALUE']) >>> df $ @area @cat01 @tab @time 0 101.2 13A01 0001 1 2019000101Pythonコンソール:地域コード>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][2]['CLASS']) >>> df['@name'].where(df['@code'] == '13A01')[0] '13100 東京都区部'Pythonコンソール:カテゴリー>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][1]['CLASS']) >>> df['@name'].where(df['@code'] == '0001')[0] '0001 総合'Pythonコンソール:表彰事項>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][0]['CLASS']) >>> df['@name'].where(df['@code'] == '1')[0] '指数'Pythonコンソール:時間軸(年・月)>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][3]['CLASS']) >>> df['@name'].where(df['@code'] == '2019000101')[0] '2019年1月'つまりソースはこうなるな?# translation to dataframe from json-data data = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['DATA_INF']['VALUE']) area = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][2]['CLASS']) category = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][1]['CLASS']) tab = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][0]['CLASS']) time = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][3]['CLASS'])複数のデータフレームをInnerJoinする

https://pandas.pydata.org/pandas-docs/stable/reference/api/pandas.DataFrame.join.html

If we want to join using the key columns, we need to set key to be the index in both df and other. The joined DataFrame will have key as its index.

キー列を使って結合したい場合は、keyをdfとotherの両方のインデックスになるように設定する必要があります。結合されたDataFrameはそのインデックスとしてキーを持ちます。公式ドキュメントのお手本>>> df.set_index('key').join(other.set_index('key')) A B key K0 A0 B0 K1 A1 B1 K2 A2 B2 K3 A3 NaN K4 A4 NaN K5 A5 NaNここから先は結合するにあたって項目名がカブってくるので列名を変更する。

data以外のデータフレームの「@name」だけでいいんじゃないかな

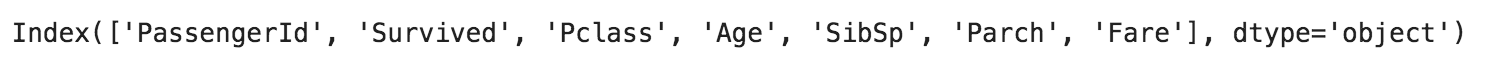

https://pandas.pydata.org/pandas-docs/stable/reference/api/pandas.DataFrame.rename.html#pandas.DataFrame.renamePythonコンソール:列構成の確認と調整、結合# 確認: >>> data.columns Index(['$', '@area', '@cat01', '@tab', '@time'], dtype='object') >>> area.columns Index(['@code', '@level', '@name'], dtype='object') >>> category.columns Index(['@code', '@level', '@name', '@parentCode'], dtype='object') >>> tab.columns Index(['@code', '@level', '@name', '@unit'], dtype='object') # 調整1: 列名変更 >>> area = area.rename(columns={'@name': 'area_name'}) >>> category = category.rename(columns={'@name': 'category_name'}) >>> tab = tab.rename(columns={'@name': 'tab_name'}) # 調整2: くっつけるとカブる列とか不要列の削除(レベルは、「全国」と「都道府県」を分けるみたいな深さ情報みたい) # エラーを出しながら判断 >>> area = area.drop(columns=['@level']) >>> category = category.drop(columns=['@level','@parentCode']) >>> tab = tab.drop(columns=['@level','@unit']) # 結合: Inner Join >>> joined = data.set_index('@area').join(area.set_index('@code')) >>> joined = joined.set_index('@cat01').join(category.set_index('@code')) >>> joined = joined.set_index('@tab').join(tab.set_index('@code')) # 確認: たぶんこれ「指数」以外もあるんだよね(「:10」で、10件だけ表示) >>> joined[:10] $ area_name category_name tab_name time_name 1970000000 31.5 全国 0001 総合 指数 1970年 1970000000 31.7 人口5万以上の市 0001 総合 指数 1970年 1970000000 31.7 大都市 0001 総合 指数 1970年 1970000000 31.8 中都市 0001 総合 指数 1970年 1970000000 31.2 小都市A 0001 総合 指数 1970年 1970000000 33.2 北海道地方 0001 総合 指数 1970年 1970000000 30.6 東北地方 0001 総合 指数 1970年 1970000000 31.5 関東地方 0001 総合 指数 1970年 1970000000 31.5 北陸地方 0001 総合 指数 1970年 1970000000 31.5 東海地方 0001 総合 指数 1970年データの加工

これ最初さー、「2019年1月」とか日本語入ってるとあとから取り回し悪くて仕方ないから int で年月項目にしようとしたんだけど13行目と14行目見て?

年度!?いらないよー。かんべんしてくださいよこれ。で、@levelって 1 と 4 以外にあるのかな?って思ってみるも、Pythonコンソールってデータを省略して見せてくるので、しかたなくcsv出力をして確認。 1 と 4 しかないことを確認できたので 1 のレコードを消しましょう。そうすれば ym にできるはず。Pythonコンソール:年どまりとか年度とかが混ざってる>>> time @code @level @name @parentCode 0 2019000101 4 2019年1月 2019000103 1 2018001212 4 2018年12月 2018001012 2 2018001111 4 2018年11月 2018001012 3 2018001010 4 2018年10月 2018001012 4 2018000909 4 2018年9月 2018000709 5 2018000808 4 2018年8月 2018000709 6 2018000707 4 2018年7月 2018000709 7 2018000606 4 2018年6月 2018000406 8 2018000505 4 2018年5月 2018000406 9 2018000404 4 2018年4月 2018000406 10 2018000303 4 2018年3月 2018000103 11 2018000202 4 2018年2月 2018000103 12 2018000101 4 2018年1月 2018000103 13 2018000000 1 2018年 NaN 14 2017100000 1 2017年度 NaN 15 2017001212 4 2017年12月 2017001012 16 2017001111 4 2017年11月 2017001012 17 2017001010 4 2017年10月 2017001012main.py:いろいろ加工しました。文字加工のエッセンスが詰まっているね# edit text to '201901' from '2019年1月' time['yyyy'] = time['time'].str.split('年', expand=True)[0] time['mm'] = time['time'].str.split('年', expand=True)[1].str.strip('月').str.zfill(2) time['yyyymm'] = time['yyyy'] + time['mm'] # If there is 'A' in the middle, it means 'city' area['city_flag'] = area['@code'].str.contains('..A..') area['area'] = area['area'].str.split(' ', expand=True)[1]API取得制限に注意な

なんかデータ足りなくない??って思って、例えばカテゴリーが「総合」か「食料」か「穀物」までしかないんだよなぁ~、くっつけかた間違えたかなぁ~??とか思ってたけどこれだったか。data の時点のデータフレームでは100,000レコードであることを確認できました。URLをクエリパラメータ作ってひっぱるときにレコード減らす工夫するしかないね。

Q7 : 【統計データ取得機能】10万件を超えるデータを取得できません。

A7 : API機能は、一度に最大で10万件のデータを返却します。そのため、統計データが一度に取得できない場合には、継続データの取得開始位置をレスポンスのタグの値として出力します。継続データを要求する場合は、データ取得開始位置パラメータ(startPosition)にこの値を指定することで、取得できます。SQLServerでテーブルを作る

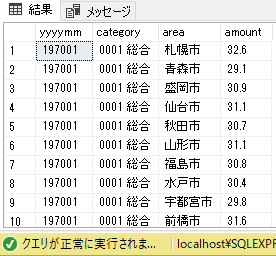

テーブル作成クエリCREATE TABLE e_Stat ( yyyymm INT NOT NULL , category NVARCHAR(50) NULL , area NVARCHAR(50) NULL , amount NUMERIC(5,1) NULL );プログラムを流してみる

あーできたー... 解散!解散ー!おつかれー

うまいもんくって寝ましょ

Pythonコンソール:上位30件のみbasic_connect-api-e_stat> python main.py 197002,0002 食料,岡山市,30.4 197004,0002 食料,福井市,29.6 197006,0002 食料,盛岡市,30.0 197008,0001 総合,山口市,32.9 197010,0001 総合,長野市,32.7 197012,0001 総合,秋田市,32.2 197101,0002 食料,松山市,33.0 197103,0002 食料,名古屋市,33.3 197105,0002 食料,水戸市,31.7 197107,0001 総合,北九州市,32.6 197109,0001 総合,大津市,34.9 197112,0001 総合,奈良市,35.4 197202,0001 総合,横浜市,34.4 197205,0002 食料,松江市,31.1 197209,0002 食料,青森市,32.8 197301,0001 総合,甲府市,35.5 197304,0002 食料,高松市,38.9 197308,0002 食料,福島市,37.7 197312,0001 総合,津市,41.6 197402,0002 食料,富山市,45.1 197402,0002 食料,金沢市,46.3 197402,0002 食料,福井市,44.7 197402,0002 食料,甲府市,46.1 197402,0002 食料,長野市,48.4 197402,0002 食料,岐阜市,45.0 197402,0002 食料,静岡市,44.6 197402,0002 食料,名古屋市,48.0 197402,0002 食料,津市,44.2 197402,0002 食料,大津市,51.6 197402,0002 食料,京都市,49.9ソースコード

ソースをgithubにしとくとあとがラクねぇ~

https://github.com/duri0214/Python/tree/master/basic_connect-api-e_stat

- 投稿日:2019-02-09T23:09:43+09:00

Pythonでe-statにAPIアクセスしてSQLServerに突っ込むときにJSONと格闘したメモ

はじめに

興味深いAPI

[2019] 公開されているAPI一覧まとめ

Netflix API | ProgrammableWeb

BloombergのAPIから価格取得をするジェイソンとデータフレーム

最初に e-stat からデータを取ろうとしたときに、jsonでの取得まではすんなりいったけど、データフレームの入れ方が悪かった(JSONとデータフレームの関係がわかってなかった)ということがあった。

Syntax(構文)

pandas.read_json

Convert a JSON string to pandas object.構文についてpandas.read_json(path_or_buf=None, orient=None)引数についてpath_or_buf : a valid JSON string or file-like, default: None orient : string, 'records' : list like [{column -> value}, ... , {column -> value}]返り値についてresult : Series or DataFrame, depending on the value of typ.JSON試行錯誤

こんな感じに書いて...import urllib import urllib.request import pandas as pd # Read appId with open('api_setting/appid.txt', mode='r', encoding='utf-8') as f: appId = f.read() # stat url url = r'http://api.e-stat.go.jp/rest/2.1/app/json/getStatsData?' # Query param setting keys = { "appId" : appId, "lang" : "J" , "statsDataId" : "0003143513" , "metaGetFlg" : "Y" , "cntGetFlg" : "N", "sectionHeaderFlg" : "1" } # Get json data query_param = urllib.parse.urlencode(keys) df = pd.read_json(urllib.request.urlopen(url + query_param).read(), orient='records') print(df)Pythonコンソール(こんなふうに出てきたので)>>> df GET_STATS_DATA PARAMETER {'LANG': 'J', 'STATS_DATA_ID': '0003143513', '... RESULT {'STATUS': 0, 'ERROR_MSG': '正常に終了しました。', 'DATE... STATISTICAL_DATA {'RESULT_INF': {'TOTAL_NUMBER': 13142278, 'FRO...Pythonコンソール(データを取る練習してたんだけど)------------- データフレームてっぺんから最下層のリテラルを取るぞ! ------------- >>> print(df.columns) Index(['GET_STATS_DATA'], dtype='object') >>> print(df['GET_STATS_DATA']) PARAMETER {'LANG': 'J', 'STATS_DATA_ID': '0003143513', '... RESULT {'STATUS': 0, 'ERROR_MSG': '正常に終了しました。', 'DATE... STATISTICAL_DATA {'RESULT_INF': {'TOTAL_NUMBER': 13142278, 'FRO... >>> print(df['GET_STATS_DATA']['RESULT']) {'STATUS': 0, 'ERROR_MSG': '正常に終了しました。', 'DATE': '2019-02-07T22:35:18.179+09:00'} # ここまでで、1つの固有値を取得できた >>> print(df['GET_STATS_DATA']['RESULT']['ERROR_MSG']) 正常に終了しました。Pythonコンソール(データフレームのまま、APIデータまでたどり着けない!)------------- Pandasで集計するぞ! ------------- # あれ、一段下がっただけでシリーズになっちまうのか...まぁそうか >>> print(type(df['GET_STATS_DATA'])) <class 'pandas.core.series.Series'> # ここから下は辞書になっちまうのか... >>> print(type(df['GET_STATS_DATA']['STATISTICAL_DATA'])) <class 'dict'> >>> print(df['GET_STATS_DATA']['STATISTICAL_DATA']['DATA_INF'].keys()) dict_keys(['NOTE', 'VALUE']) ???? >>> print(df['GET_STATS_DATA']['STATISTICAL_DATA']['DATA_INF']['VALUE']) (・3・)アルェー?とにかくデータフレームのまま操作したいのにできない。というハマりポイントがあった。ただこれ整理してみると、JSONデータであればデータフレームの入れ物にはスポッと入ってくれる。ただ、jsonの最初には大概ヘッダが入っている。つまり、データフレームに入れる時点で十分に階層を降りていないといけないということがわかった。

https://dev.classmethod.jp/etc/concrete-example-of-json/JSONデータの例(あーなるほど、たしかにヘッダが入ってるわ...)[ { "InstanceId": "i-XXXXXXXX", "ImageId": "ami-YYYYYYYY", "LaunchTime": "2015-05-28T08:30:10.000Z", "Tags": [ { "Value": "portnoydev-emr", "Key": "Name" }, { "Value": "j-ZZZZZZZZZZZZ", "Key": "aws:elasticmapreduce:job-flow-id" }, { "Value": "CORE", "Key": "aws:elasticmapreduce:instance-group-role" } ] }, (略) ]Pythonコンソール(なのでデータフレームに入れるのはJSONナマじゃなくて...)>>> df = pd.read_json(urllib.request.urlopen(url + query_param).read(), orient='records')Pythonコンソール(こうなんやな!)>>> df = pd.read_json(urllib.request.urlopen(url + query_param).read(), orient='records')['GET_STATS_DATA']['STATISTICAL_DATA'] >>> print(type(df)) <class 'dict'> (・3・)アルェー?Pythonコンソール(オライリーを見てみると、辞書をデータフレームに変換してた)>>> print(type(result['GET_STATS_DATA']['STATISTICAL_DATA'])) <class 'dict'> >>> stats = pd.DataFrame(result['GET_STATS_DATA']['STATISTICAL_DATA']) >>> print(type(stats)) <class 'pandas.core.frame.DataFrame'> >>> stats RESULT_INF ... DATA_INF @id NaN ... NaN CLASS_OBJ NaN ... NaN CYCLE NaN ... NaN FROM_NUMBER 1.0 ... NaN GOV_ORG NaN ... NaN MAIN_CATEGORY NaN ... NaN NEXT_KEY 100001.0 ... NaN NOTE NaN ... {'@char': '***', '$': '該当データがない場合を示す。'} OPEN_DATE NaN ... NaN OVERALL_TOTAL_NUMBER NaN ... NaN SMALL_AREA NaN ... NaN STATISTICS_NAME NaN ... NaN STATISTICS_NAME_SPEC NaN ... NaN STAT_NAME NaN ... NaN SUB_CATEGORY NaN ... NaN SURVEY_DATE NaN ... NaN TITLE NaN ... NaN TITLE_SPEC NaN ... NaN TOTAL_NUMBER 13142278.0 ... NaN TO_NUMBER 100000.0 ... NaN UPDATED_DATE NaN ... NaN VALUE NaN ... [{'@tab': '1', '@cat01': '0001', '@area': '13A... [22 rows x 4 columns]Pythonコンソール(VALUEまで取りに行けばいいじゃん?...ダメらしい...)>>> stats = pd.DataFrame(result['GET_STATS_DATA']['STATISTICAL_DATA']['VALUE']) Traceback (most recent call last): File "<stdin>", line 1, in <module> KeyError: 'VALUE'たしかにそこにいるはずなんだが...

なんかもう昔のゲームやってるみたいだわ、3次元以上の配列って...(この感じわかるひといる?)

ん?

Pythonコンソール(なるほど?いままでの単純な表形式の見方を発展させないといけないか)>>> stats.columns Index(['RESULT_INF', 'TABLE_INF', 'CLASS_INF', 'DATA_INF'], dtype='object') >>> stats['DATA_INF'] @id NaN CLASS_OBJ NaN CYCLE NaN FROM_NUMBER NaN GOV_ORG NaN MAIN_CATEGORY NaN NEXT_KEY NaN NOTE {'@char': '***', '$': '該当データがない場合を示す。'} OPEN_DATE NaN OVERALL_TOTAL_NUMBER NaN SMALL_AREA NaN STATISTICS_NAME NaN STATISTICS_NAME_SPEC NaN STAT_NAME NaN SUB_CATEGORY NaN SURVEY_DATE NaN TITLE NaN TITLE_SPEC NaN TOTAL_NUMBER NaN TO_NUMBER NaN UPDATED_DATE NaN VALUE [{'@tab': '1', '@cat01': '0001', '@area': '13A... Name: DATA_INF, dtype: object # これやるとデータがずばーっと出てくるので >>> stats['DATA_INF']['VALUE'] # 5レコードにおさえる >>> stats['DATA_INF']['VALUE'][0:5] [{'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2019000101', '$': '101.2'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018001212', '$': '101.2'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018001111', '$': '101.4'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018001010', '$': '101.7'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018000909', '$': '101.4'}]5レコードのJSONを整理する>>> stats['DATA_INF']['VALUE'][0:5] [ {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2019000101', '$': '101.2'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018001212', '$': '101.2'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018001111', '$': '101.4'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018001010', '$': '101.7'}, {'@tab': '1', '@cat01': '0001', '@area': '13A01', '@time': '2018000909', '$': '101.4'} ]Pythonコンソール(listかぁ...これもういっちょデータフレームにキャストしてみるか)>>> print(type(stats['DATA_INF']['VALUE'])) <class 'list'> # あっ!なんかキタぞ!めっちゃ試行錯誤いるなぁ...JSON... >>> df = pd.DataFrame(stats['DATA_INF']['VALUE']) >>> df $ @area @cat01 @tab @time 0 101.2 13A01 0001 1 2019000101 1 101.2 13A01 0001 1 2018001212 2 101.4 13A01 0001 1 2018001111 3 101.7 13A01 0001 1 2018001010 4 101.4 13A01 0001 1 2018000909 ... ... ... ... ... ... 99995 100.9 00049 0003 1 2011000808 99996 100.8 00049 0003 1 2011000707 99997 99.6 00049 0003 1 2011000606 99998 99.9 00049 0003 1 2011000505 99999 99.4 00049 0003 1 2011000404 [100000 rows x 5 columns] >>> df['$'] 0 101.2 1 101.2 2 101.4 3 101.7 4 101.4 ... 99995 100.9 99996 100.8 99997 99.6 99998 99.9 99999 99.4 Name: $, Length: 100000, dtype: object >>> df['@time'] 0 2019000101 1 2018001212 2 2018001111 3 2018001010 4 2018000909 ... 99995 2011000808 99996 2011000707 99997 2011000606 99998 2011000505 99999 2011000404 Name: @time, Length: 100000, dtype: object補足:見てるオライリーはこれ

オライリーって無骨だけど読みやすいよね

JSONコンソール操作まとめ

res(=Full JSON) が返ってきてから、dfに入れる直前までの間に、単純なタテヨコの一般的な(?)2元配列になるところまで十分にJSON配列(?)を潜ってからデータフレームに渡すんや。...というよりは、dfに代入してデータフレーム手に入ったー!って思ってたのはただのナマJSONだった(pd.DataFrame(...)の漏れ)

Pythonコンソール>>> import urllib >>> import urllib.request >>> import pandas as pd >>> appId = '****************************' >>> url = r'http://api.e-stat.go.jp/rest/2.1/app/json/getStatsData?' >>> keys = { "appId" : appId, "lang" : "J" , "statsDataId" : "0003143513" , "metaGetFlg" : "Y" , "cntGetFlg" : "N", "sectionHeaderFlg" : "1" } >>> query_param = urllib.parse.urlencode(keys) >>> res = pd.read_json(urllib.request.urlopen(url + query_param).read(), orient='records') >>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['DATA_INF']['VALUE']) >>> df $ @area @cat01 @tab @time 0 101.2 13A01 0001 1 2019000101 1 101.2 13A01 0001 1 2018001212 2 101.4 13A01 0001 1 2018001111 3 101.7 13A01 0001 1 2018001010 4 101.4 13A01 0001 1 2018000909 ... ... ... ... ... ... 99995 100.9 00049 0003 1 2011000808 99996 100.8 00049 0003 1 2011000707 99997 99.6 00049 0003 1 2011000606 99998 99.9 00049 0003 1 2011000505 99999 99.4 00049 0003 1 2011000404 [100000 rows x 5 columns] >>> df['$'] 0 101.2 1 101.2 2 101.4 3 101.7 4 101.4 ... 99995 100.9 99996 100.8 99997 99.6 99998 99.9 99999 99.4 Name: $, Length: 100000, dtype: object >>> df['@time'] 0 2019000101 1 2018001212 2 2018001111 3 2018001010 4 2018000909 ... 99995 2011000808 99996 2011000707 99997 2011000606 99998 2011000505 99999 2011000404 Name: @time, Length: 100000, dtype: object

ようやく僕が知ってるデータフレームまできたぁ~

いっかい寝よ...つべこべいわずにJSON整形サイトに流し込め!

http://tm-webtools.com/Tools/JsonBeauty

元のデータを知らない(作ってない)んだから試行錯誤になるのはあたりまえ!あっ!階層一撃で追えるわ...トホホ{ "GET_STATS_DATA": { "RESULT": { "STATUS": 0, "ERROR_MSG": "正常に終了しました。", "DATE": "2019-02-08T21:16:05.801+09:00" }, "PARAMETER": { "LANG": "J", "STATS_DATA_ID": "0003143513", "DATA_FORMAT": "J", "START_POSITION": 1, "METAGET_FLG": "Y", "CNT_GET_FLG": "N", "SECTION_HEADER_FLG": 1 }, "STATISTICAL_DATA": { "RESULT_INF": { "TOTAL_NUMBER": 13142278, "FROM_NUMBER": 1, "TO_NUMBER": 100000, "NEXT_KEY": 100001 }, "TABLE_INF": { "@id": "0003143513", "STAT_NAME": { "@code": "00200573", "$": "消費者物価指数" }, "GOV_ORG": { "@code": "00200", "$": "総務省" }, "STATISTICS_NAME": "2015年基準消費者物価指数", "TITLE": { "@no": "1", "$": "消費者物価指数(2015年基準)" }, "CYCLE": "-", "SURVEY_DATE": 0, "OPEN_DATE": "2019-01-25", "SMALL_AREA": 0, "MAIN_CATEGORY": { "@code": "07", "$": "企業・家計・経済" }, "SUB_CATEGORY": { "@code": "03", "$": "物価" }, "OVERALL_TOTAL_NUMBER": 13142278, "UPDATED_DATE": "2019-01-24", "STATISTICS_NAME_SPEC": { "TABULATION_CATEGORY": "2015年基準消費者物価指数" }, "TITLE_SPEC": { "TABLE_NAME": "消費者物価指数(2015年基準)" } }, "CLASS_INF": { "CLASS_OBJ": [ { "@id": "tab", "@name": "表章項目", "CLASS": [ { "@code": "1", "@name": "指数", "@level": "" }, { "@code": "2", "@name": "前月比・前年比・前年度比", "@level": "", "@unit": "%" }, { "@code": "3", "@name": "前年同月比", "@level": "", "@unit": "%" }, { "@code": "4", "@name": "ウエイト(実数)", "@level": "" }, { "@code": "5", "@name": "ウエイト(万分比)", "@level": "" } ] }, { "@id": "cat01", "@name": "2015年基準品目", "CLASS": [ { "@code": "0001", "@name": "0001 総合", "@level": "1" }, { "@code": "0002", "@name": "0002 食料", "@level": "1" }, { "@code": "0003", "@name": "0003 穀類", "@level": "3", "@parentCode": "0002" }, (略) ] } ] }, "DATA_INF": { "NOTE": { "@char": "***", "$": "該当データがない場合を示す。" }, "VALUE": [ { "@tab": "1", "@cat01": "0001", "@area": "13A01", "@time": "2019000101", "$": "101.2" }, { "@tab": "1", "@cat01": "0001", "@area": "13A01", "@time": "2018001212", "$": "101.2" }, { "@tab": "1", "@cat01": "0001", "@area": "13A01", "@time": "2018001111", "$": "101.4" }, (略) ] } } } }e-Stat

(JSONの試行錯誤は上のセクションにまとめたので、それ以外を書きます)

参考ページ

e-Stat(政府統計)のAPI機能をつかってpythonでグラフを書いたりしてみる

APIの使い方 how_to_use前準備情報等

・ユーザー登録

・ログインしてマイページ→API機能(アプリケーションID発行)

・名称は「開発用」

・URLは「ttp://localhost/」(※Qiitaだとリンクになっちゃうから先頭の h は削除)

消費者物価指数 2015年基準消費者物価指数(公開日:2019-01-25)

消費者物価指数(URLをよく見ると「appId」に何も入っていない)(使い方を見て、jsonで表示するように加工してある)http://api.e-stat.go.jp/rest/2.1/app/json/getStatsData?appId=&lang=J&statsDataId=0003143513&metaGetFlg=Y&cntGetFlg=N§ionHeaderFlg=1データについて

db形式で表示されるページがあるなら先に構造を見ておけってのは、まぁあたりまえっちゃあたりまえだったね

このへんかな?

https://www.e-stat.go.jp/api/api-info/e-stat-manual#api_3_4うーん?cdArea 地域事項? lvCat01 分類事項01? cdTab 表章事項? lvTime 時間軸事項?VALUE 統計数値(セル)の情報です。データ件数分だけ出力されます。

属性として表章事項コード(tab)、分類事項コード(cat01 ~ cat15)、地域事項コード(area)、時間軸事項コード(time)、単位(unit)を保持します。全ての属性はデータがある場合のみ出力されます。単語:表章 https://www.stat.go.jp/data/kokusei/2010/users-g/pdf/mikata.pdf

うーん、例えば地域コード 13A01 はどこだよ!?マスタは?みたいな感じになるよなぁ~??

Pythonコンソール>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['DATA_INF']['VALUE']) >>> df $ @area @cat01 @tab @time 0 101.2 13A01 0001 1 2019000101 1 101.2 13A01 0001 1 2018001212 2 101.4 13A01 0001 1 2018001111 3 101.7 13A01 0001 1 2018001010 4 101.4 13A01 0001 1 2018000909 ... ... ... ... ... ... 99995 100.9 00049 0003 1 2011000808 99996 100.8 00049 0003 1 2011000707 99997 99.6 00049 0003 1 2011000606 99998 99.9 00049 0003 1 2011000505 99999 99.4 00049 0003 1 2011000404 [100000 rows x 5 columns]Pythonコンソール(あっ!わかった!同じJSONに入ってるぞ!CLASS_INFだ)>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ']) >>> df @id @name CLASS 0 tab 表章項目 [{'@code': '1', '@name': '指数', '@level': ''}, ... 1 cat01 2015年基準品目 [{'@code': '0001', '@name': '0001 総合', '@level... 2 area 地域(2015年基準) [{'@code': '13A01', '@name': '13100 東京都区部', '@... 3 time 時間軸(年・月) [{'@code': '2019000101', '@name': '2019年1月', '...整形サイト http://tm-webtools.com/Tools/JsonBeauty でJSONとにらめっこだな。

わかってきたのは...Pythonコンソール>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][0]['CLASS']) >>> df @code @level @name @unit 0 1 指数 NaN 1 2 前月比・前年比・前年度比 % 2 3 前年同月比 % 3 4 ウエイト(実数) NaN 4 5 ウエイト(万分比) NaNPythonコンソール>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][1]['CLASS']) >>> df @code @level @name @parentCode 0 0001 1 0001 総合 NaN 1 0002 1 0002 食料 NaN 2 0003 3 0003 穀類 0002 3 0004 5 0004 米類 0003 4 1000 6 1000 うるち米 0004 .. ... ... ... ... 793 0905 1 0905 食料(酒類を除く)及びエネルギーを除く総合(季節調整済) NaN 794 0921 1 0921 財(季節調整済) NaN 795 0922 1 0922 半耐久消費財(季節調整済) NaN 796 0923 1 0923 生鮮食品を除く財(季節調整済) NaN 797 0906 1 0906 生鮮食品及びエネルギーを除く総合(季節調整済) NaN [798 rows x 4 columns]Pythonコンソール>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][2]['CLASS']) >>> df @code @level @name 0 13A01 1 13100 東京都区部 1 00000 1 全国 2 00011 1 人口5万以上の市 3 00012 1 大都市 4 00013 1 中都市 .. ... ... ... 67 14A02 1 14130 川崎市 68 14A03 1 14150 相模原市 69 22A02 1 22130 浜松市 70 27A02 1 27140 堺市 71 40A01 1 40100 北九州市 [72 rows x 3 columns]Pythonコンソール>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][3]['CLASS']) >>> df @code @level @name @parentCode 0 2019000101 4 2019年1月 2019000103 1 2018001212 4 2018年12月 2018001012 2 2018001111 4 2018年11月 2018001012 3 2018001010 4 2018年10月 2018001012 4 2018000909 4 2018年9月 2018000709 .. ... ... ... ... 681 1970000404 4 1970年4月 1970000000 682 1970000303 4 1970年3月 1970000000 683 1970000202 4 1970年2月 1970000000 684 1970000101 4 1970年1月 1970000000 685 1970000000 1 1970年 NaN [686 rows x 4 columns]つまり...どういうことだってばよ

データフレームに SQL:Where を適用する

https://pandas.pydata.org/pandas-docs/stable/reference/api/pandas.DataFrame.where.html

まぁ4つのマスタはそれぞれ違うデータフレームに受け取るのがわかりやすいとは思うけどPythonコンソール(この明細を例にとったときに...)>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['DATA_INF']['VALUE']) >>> df $ @area @cat01 @tab @time 0 101.2 13A01 0001 1 2019000101Pythonコンソール:地域コード>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][2]['CLASS']) >>> df['@name'].where(df['@code'] == '13A01')[0] '13100 東京都区部'Pythonコンソール:カテゴリー>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][1]['CLASS']) >>> df['@name'].where(df['@code'] == '0001')[0] '0001 総合'Pythonコンソール:表彰事項>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][0]['CLASS']) >>> df['@name'].where(df['@code'] == '1')[0] '指数'Pythonコンソール:時間軸(年・月)>>> df = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][3]['CLASS']) >>> df['@name'].where(df['@code'] == '2019000101')[0] '2019年1月'つまりソースはこうなるな?# translation to dataframe from json-data data = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['DATA_INF']['VALUE']) area = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][2]['CLASS']) category = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][1]['CLASS']) tab = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][0]['CLASS']) time = pd.DataFrame(res['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ'][3]['CLASS'])複数のデータフレームをInnerJoinする

https://pandas.pydata.org/pandas-docs/stable/reference/api/pandas.DataFrame.join.html

If we want to join using the key columns, we need to set key to be the index in both df and other. The joined DataFrame will have key as its index.

キー列を使って結合したい場合は、keyをdfとotherの両方のインデックスになるように設定する必要があります。結合されたDataFrameはそのインデックスとしてキーを持ちます。公式ドキュメントのお手本>>> df.set_index('key').join(other.set_index('key')) A B key K0 A0 B0 K1 A1 B1 K2 A2 B2 K3 A3 NaN K4 A4 NaN K5 A5 NaNここから先は結合するにあたって項目名がカブってくるので列名を変更する。

data以外のデータフレームの「@name」だけでいいんじゃないかな

https://pandas.pydata.org/pandas-docs/stable/reference/api/pandas.DataFrame.rename.html#pandas.DataFrame.renamePythonコンソール:列構成の確認と調整、結合# 確認: >>> data.columns Index(['$', '@area', '@cat01', '@tab', '@time'], dtype='object') >>> area.columns Index(['@code', '@level', '@name'], dtype='object') >>> category.columns Index(['@code', '@level', '@name', '@parentCode'], dtype='object') >>> tab.columns Index(['@code', '@level', '@name', '@unit'], dtype='object') # 調整1: 列名変更 >>> area = area.rename(columns={'@name': 'area_name'}) >>> category = category.rename(columns={'@name': 'category_name'}) >>> tab = tab.rename(columns={'@name': 'tab_name'}) # 調整2: くっつけるとカブる列とか不要列の削除(レベルは、「全国」と「都道府県」を分けるみたいな深さ情報みたい) # エラーを出しながら判断 >>> area = area.drop(columns=['@level']) >>> category = category.drop(columns=['@level','@parentCode']) >>> tab = tab.drop(columns=['@level','@unit']) # 結合: Inner Join >>> joined = data.set_index('@area').join(area.set_index('@code')) >>> joined = joined.set_index('@cat01').join(category.set_index('@code')) >>> joined = joined.set_index('@tab').join(tab.set_index('@code')) # 確認: たぶんこれ「指数」以外もあるんだよね(「:10」で、10件だけ表示) >>> joined[:10] $ area_name category_name tab_name time_name 1970000000 31.5 全国 0001 総合 指数 1970年 1970000000 31.7 人口5万以上の市 0001 総合 指数 1970年 1970000000 31.7 大都市 0001 総合 指数 1970年 1970000000 31.8 中都市 0001 総合 指数 1970年 1970000000 31.2 小都市A 0001 総合 指数 1970年 1970000000 33.2 北海道地方 0001 総合 指数 1970年 1970000000 30.6 東北地方 0001 総合 指数 1970年 1970000000 31.5 関東地方 0001 総合 指数 1970年 1970000000 31.5 北陸地方 0001 総合 指数 1970年 1970000000 31.5 東海地方 0001 総合 指数 1970年データの加工

これ最初さー、「2019年1月」とか日本語入ってるとあとから取り回し悪くて仕方ないから int で年月項目にしようとしたんだけど13行目と14行目見て?

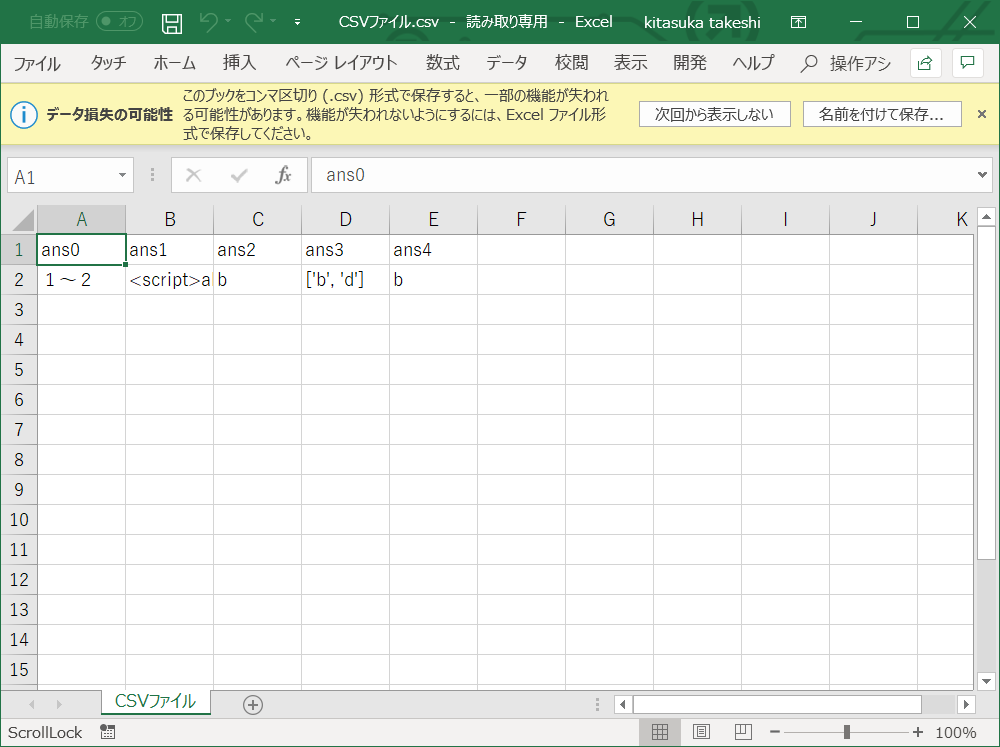

年度!?いらないよー。かんべんしてくださいよこれ。で、@levelって 1 と 4 以外にあるのかな?って思ってみるも、Pythonコンソールってデータを省略して見せてくるので、しかたなくcsv出力をして確認。 1 と 4 しかないことを確認できたので 1 のレコードを消しましょう。そうすれば ym にできるはず。Pythonコンソール:年どまりとか年度とかが混ざってる>>> time @code @level @name @parentCode 0 2019000101 4 2019年1月 2019000103 1 2018001212 4 2018年12月 2018001012 2 2018001111 4 2018年11月 2018001012 3 2018001010 4 2018年10月 2018001012 4 2018000909 4 2018年9月 2018000709 5 2018000808 4 2018年8月 2018000709 6 2018000707 4 2018年7月 2018000709 7 2018000606 4 2018年6月 2018000406 8 2018000505 4 2018年5月 2018000406 9 2018000404 4 2018年4月 2018000406 10 2018000303 4 2018年3月 2018000103 11 2018000202 4 2018年2月 2018000103 12 2018000101 4 2018年1月 2018000103 13 2018000000 1 2018年 NaN 14 2017100000 1 2017年度 NaN 15 2017001212 4 2017年12月 2017001012 16 2017001111 4 2017年11月 2017001012 17 2017001010 4 2017年10月 2017001012main.py:いろいろ加工しました。文字加工のエッセンスが詰まっているね# edit text to '201901' from '2019年1月' time['yyyy'] = time['time'].str.split('年', expand=True)[0] time['mm'] = time['time'].str.split('年', expand=True)[1].str.strip('月').str.zfill(2) time['yyyymm'] = time['yyyy'] + time['mm'] # If there is 'A' in the middle, it means 'city' area['city_flag'] = area['@code'].str.contains('..A..') area['area'] = area['area'].str.split(' ', expand=True)[1]API取得制限に注意な

なんかデータ足りなくない??って思って、例えばカテゴリーが「総合」か「食料」か「穀物」までしかないんだよなぁ~、くっつけかた間違えたかなぁ~??とか思ってたけどこれだったか。data の時点のデータフレームでは100,000レコードであることを確認できました。URLをクエリパラメータ作ってひっぱるときにレコード減らす工夫するしかないね。

Q7 : 【統計データ取得機能】10万件を超えるデータを取得できません。

A7 : API機能は、一度に最大で10万件のデータを返却します。そのため、統計データが一度に取得できない場合には、継続データの取得開始位置をレスポンスのタグの値として出力します。継続データを要求する場合は、データ取得開始位置パラメータ(startPosition)にこの値を指定することで、取得できます。SQLServerでテーブルを作る

テーブル作成クエリCREATE TABLE e_Stat ( yyyymm INT NOT NULL , category NVARCHAR(50) NULL , area NVARCHAR(50) NULL , amount NUMERIC(5,1) NULL );プログラムを流してみる

あーできたー... 解散!解散ー!おつかれー

うまいもんくって寝ましょ

Pythonコンソール:上位30件のみbasic_connect-api-e_stat> python main.py 197002,0002 食料,岡山市,30.4 197004,0002 食料,福井市,29.6 197006,0002 食料,盛岡市,30.0 197008,0001 総合,山口市,32.9 197010,0001 総合,長野市,32.7 197012,0001 総合,秋田市,32.2 197101,0002 食料,松山市,33.0 197103,0002 食料,名古屋市,33.3 197105,0002 食料,水戸市,31.7 197107,0001 総合,北九州市,32.6 197109,0001 総合,大津市,34.9 197112,0001 総合,奈良市,35.4 197202,0001 総合,横浜市,34.4 197205,0002 食料,松江市,31.1 197209,0002 食料,青森市,32.8 197301,0001 総合,甲府市,35.5 197304,0002 食料,高松市,38.9 197308,0002 食料,福島市,37.7 197312,0001 総合,津市,41.6 197402,0002 食料,富山市,45.1 197402,0002 食料,金沢市,46.3 197402,0002 食料,福井市,44.7 197402,0002 食料,甲府市,46.1 197402,0002 食料,長野市,48.4 197402,0002 食料,岐阜市,45.0 197402,0002 食料,静岡市,44.6 197402,0002 食料,名古屋市,48.0 197402,0002 食料,津市,44.2 197402,0002 食料,大津市,51.6 197402,0002 食料,京都市,49.9ソースコード

ソースをgithubにしとくとあとがラクねぇ~

https://github.com/duri0214/Python/tree/master/basic_connect-api-e_stat

- 投稿日:2019-02-09T23:04:30+09:00

pandasで全要素が条件を満たすSeriesを抽出

はじめに

pandasの

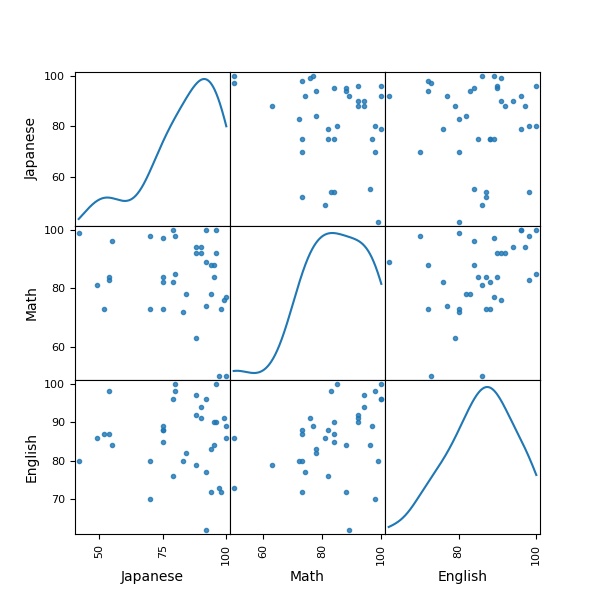

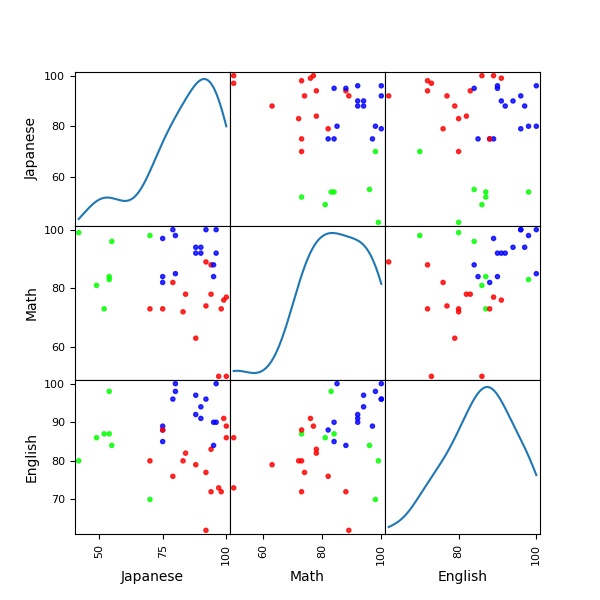

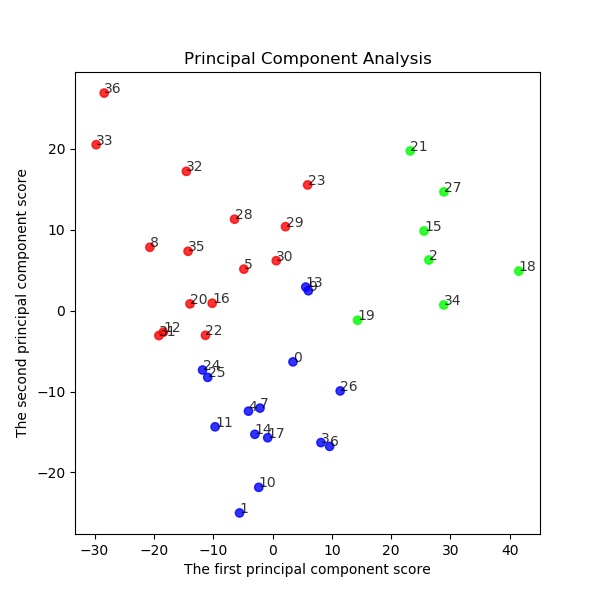

DataFrameに対し条件を指定し、全要素がそれを満たすSeries(行または列)のみを抽出します。例えば、以下のようなデータがあるとします。

行は生徒、列は教科で、各要素はテストの点数を格納しています。

English Math Science Arts Tim 48 54 82 50 David 68 58 50 72 Alex 61 58 68 48 Abdi 61 82 60 66 Lisa 58 51 34 73 このとき、例えば、全てのテストで50点以上を獲得した生徒(DavidとAbdi)のみを取得、

もしくは全生徒が50点以上を取った教科(Math)のみを取得することが目的です。以下、環境。

- OS:Ubuntu 16.04 LTS

- python 3.5.2

- pandas 0.24.1

また、本記事は公式Documentationを参照しています。

結論

上記のデータが

data.csvに保存されているとき、以下のように1行で取得可能です。import numpy as np import pandas as pd # データの読み込み df = pd.read_csv('data.csv', index_col=0, header=0) print(df) # English Math Science Arts # Tim 48 54 82 50 # David 68 58 53 72 # Alex 61 58 68 48 # Abdi 61 82 60 66 # Lisa 58 51 34 73 # 全てのテストで50点以上を取った生徒(行)の取得 print(df[df >= 50].dropna(how='any')) # English Math Science Arts # David 68.0 58 53.0 72.0 # Abdi 61.0 82 60.0 66.0 # 全生徒が50点以上取得した教科(列)の取得 print(df[df >= 50].dropna(how='any', axis=1)) # Math # Tim 54 # David 58 # Alex 58 # Abdi 82 # Lisa 51解説

使っているpandasの機能は以下の2つです。

1.boolen indexingによる要素のTrue False判定

2.dropna()によるNaN要素を持つ行(列)の削除まずpandasのboolen indexingを使って、要素の判定を行います。

同じデータを使って、何をやっているか見ていきましょう。

DataFrameに対し、比較演算子>,>=,<,<=や、等価演算==で要素の評価を行います。

その結果をDataFrameに大括弧[]で渡してあげることで、Falseの要素がNaNになります。import numpy as np import pandas as pd # データの読み込み df = pd.read_csv('data.csv', index_col=0, header=0) # 要素が50以上の要素Trueに、 # 条件を満たさない要素をFalseに df_bool = df >= 50 print(df_bool) # English Math Science Arts # Tim False True True True # David True True True True # Alex True True True False # Abdi True True True True # Lisa True True False True # Falseの要素をNaNに df_nan = df[df_bool] print(df_nan) # English Math Science Arts # Tim NaN 54 82.0 50.0 # David 68.0 58 53.0 72.0 # Alex 61.0 58 68.0 NaN # Abdi 61.0 82 60.0 66.0 # Lisa 58.0 51 NaN 73.0

DataFrame.dropnaは要素にNaNを持つSeriesに対する操作を行うAPIです。

オプションとして、

axis:行か列のどちらに対する操作かを決定。axis=0(デフォルト)で行に対する操作、axis=1で列に対する操作。how:how='any'で要素に1つでもNaNがあればdrop、how='all'で全ての要素がNaNのとき削除などがあります。他のオプションは今回使わないので割愛。詳細は公式Documentationを参照。

# 先ほどのスクリプトの続き print(df_nan) # English Math Science Arts # Tim NaN 54 82.0 50.0 # David 68.0 58 53.0 72.0 # Alex 61.0 58 68.0 NaN # Abdi 61.0 82 60.0 66.0 # Lisa 58.0 51 NaN 73.0 # NaNを1つでも持つ行を削除 df_rows = df_nan.dropna(how='any') print(df_rows) # English Math Science Arts # David 68.0 58 50.0 72.0 # Abdi 61.0 82 60.0 66.0 # NaNを1つでも持つ列を削除 df_cols = df_nan.dropna(how='any', axis=1) print(df_cols) # Math # Tim 54 # David 58 # Alex 58 # Abdi 82 # Lisa 51以上です。

pandas本当に便利ですね!

データ分析には欠かせません。おまけ

以下、関連してよく使いそうな使い方をまとめます。

複数の条件を満たすSeriesの取得

論理積

&、論理和|で複数の条件を指定可能です。

ちなみに否定~も使えます。

また、等価演算子==では文字の評価も行えます。df = pd.read_csv('data.csv', index_col=0, header=0) print(df) # English Math Science Arts # Tim 48 54 82 50 # David 68 58 50 72 # Alex 61 58 68 48 # Abdi 61 82 60 66 # Lisa 58 51 34 73 # 50点以上、かつ80点より小さい行 print(df[(df >= 50) & ~(df >= 80)].dropna(how='any')) # English Math Science Arts # David 68.0 58.0 50.0 72.0 # ちなみに文字の評価も可能 df2 = pd.DataFrame([list('abc'), list('def')]) print(df2) # 0 1 2 # 0 a b c # 1 d e f # 'a'または'e'をTrue print((df2 == 'a') | (df2 == 'e')) # 0 1 2 # 0 True False False # 1 False True False条件を満たす行(または列)の要素数をカウント

DataFrame.sumは要素の合計値(もしくは文字列を連結したもの)を取得するAPIです。

Trueは1、Falseは0と判断されるため、条件に合う要素数をカウントする使い方も可能です。

axis=0(デフォルト)で列方向に合計、axis=1で行方向に合計します。

詳しいオプションは公式を参照。# 先ほどの生徒とテストの結果のデータを使います print(df) # English Math Science Arts # Tim 48 54 82 50 # David 68 58 50 72 # Alex 61 58 68 48 # Abdi 61 82 60 66 # Lisa 58 51 34 73 # 要素が50以上の要素Trueに、条件を満たさない要素をFalseに df_bool = df >= 50 print(df_bool) # English Math Science Arts # Tim False True True True # David True True True True # Alex True True True False # Abdi True True True True # Lisa True True False True # 列方向に合計 print(df_bool.sum()) # English 4 # Math 5 # Science 4 # Arts 4 # dtype: int64 # 行方向に合計 print(df_bool.sum(axis=1)) # Tim 3 # David 4 # Alex 3 # Abdi 4 # Lisa 3 # dtype: int64

- 投稿日:2019-02-09T22:51:51+09:00

【Django】Djangoで開発環境の構築から、facebookAPIを使いfacebookでユーザー認証を行うところまでのTips②

Django-Facebookを使ってFacebook認証を実装

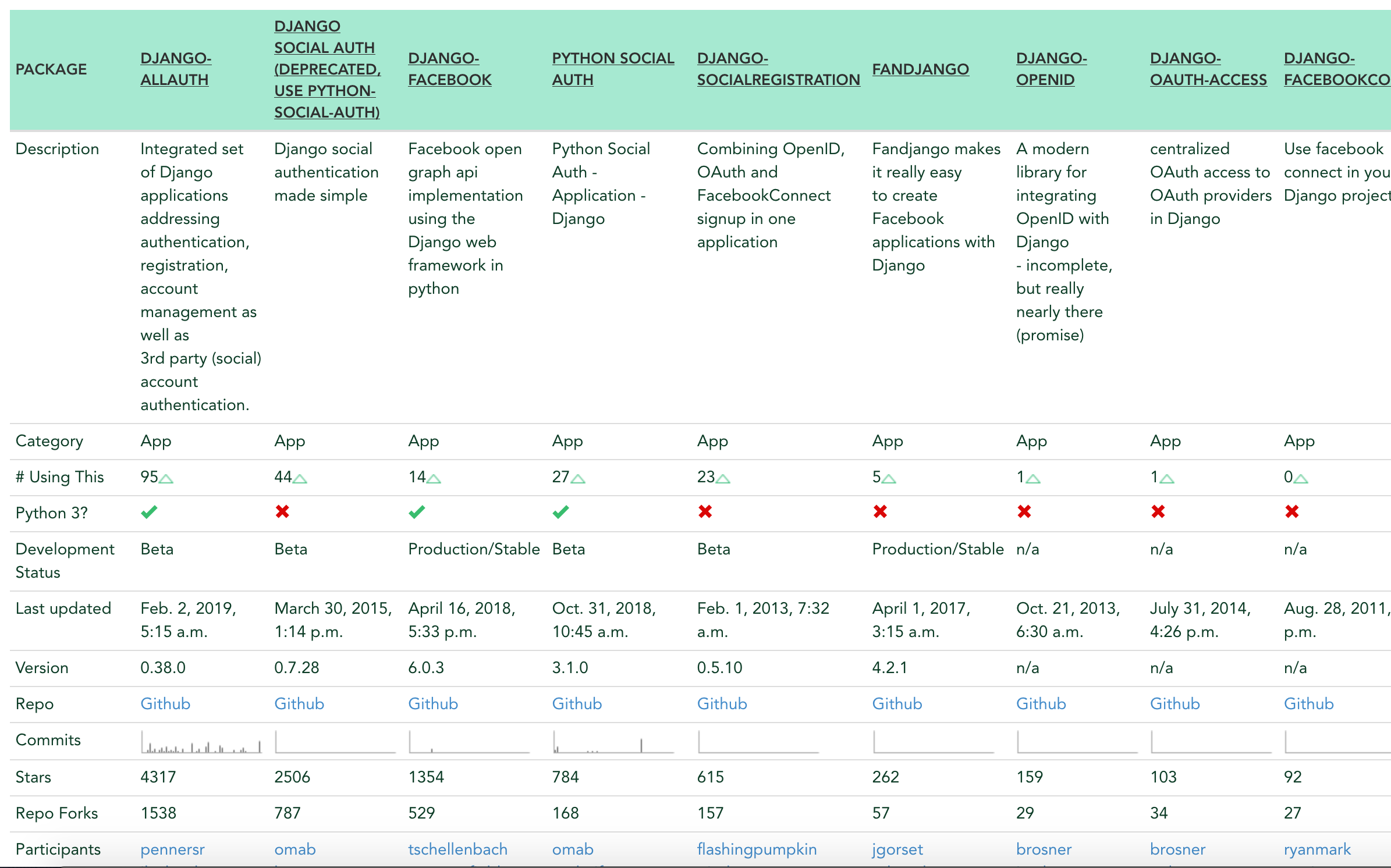

Djangoが用意しているSNSアカウント認証のパッケージはいくつもありますが(https://djangopackages.org/grids/g/facebook-authentication/ )、

一般的にDjango-Allauthが広く使われています。$pip install django-allauth .... Installing collected packages: defusedxml, python3-openid, oauthlib, urllib3, certifi, chardet, idna, requests, requests-oauthlib, django-allauth Running setup.py install for django-allauth ... done Successfully installed certifi-2018.11.29 chardet-3.0.4 defusedxml-0.5.0 django-allauth-0.38.0 idna-2.8 oauthlib-3.0.1 python3-openid-3.1.0 requests-2.21.0 requests-oauthlib-1.2.0 urllib3-1.24.1

config/settings.pyに下の最後の4行を追加しますconfig/settings.pyINSTALLED_APPS = [ 'django.contrib.admin', 'django.contrib.auth', INSTALLED_APPS = [ 'django.contrib.admin', 'django.contrib.auth', 'django.contrib.contenttypes', 'django.contrib.sessions', 'django.contrib.messages', 'django.contrib.staticfiles', 'django.contrib.sites', 'allauth', 'allauth.account', 'allauth.socialaccount', 'allauth.socialaccount.providers.facebook', ]django-allauthはsitesフレームワークの利用が必要になります。

そこでDjangoサイトを識別する為に、以下の設定を付け加えます。config/settings.pySITE_ID = 1config/urls.pyurlpatterns = [ path('admin/', admin.site.urls), path('', TemplateView.as_view(template_name='home.html'), name='home'), path('accounts/', include('allauth.urls')), ] #<=変更するFacebookディベロッパーに登録

まずはこちらのリンクから、Facebookディベロッパー登録します。

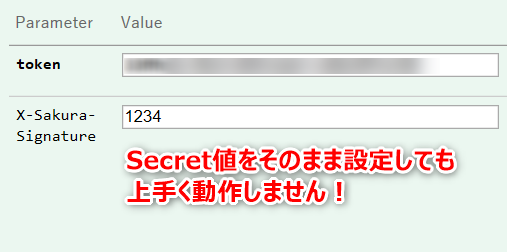

https://developers.facebook.com/アプリIDとSecret keyを取得できます。これは後ほど使います。

もし登録はしたことがあるけど自分のアプリIDとSecret keyがわからないという方は、ログイン後トップ画面の

左側のツールバーから[設定]=>[ベーシック]から調べることが可能です。続いてmigrate、runserverします。

$python manage.py migrate $python manage.py createsuperuser #管理者のユーザー名、メールアドレス、Passwordを求められる $python manage.py runserverhttp://localhost:8000/admin/ に先ほどcreatesuperuserして作成した管理者アカウントでログイン。

そしてログイン後、「サイト」にアクセスすると,

example.com というサイトができていることがわかります。管理画面トップに戻り、

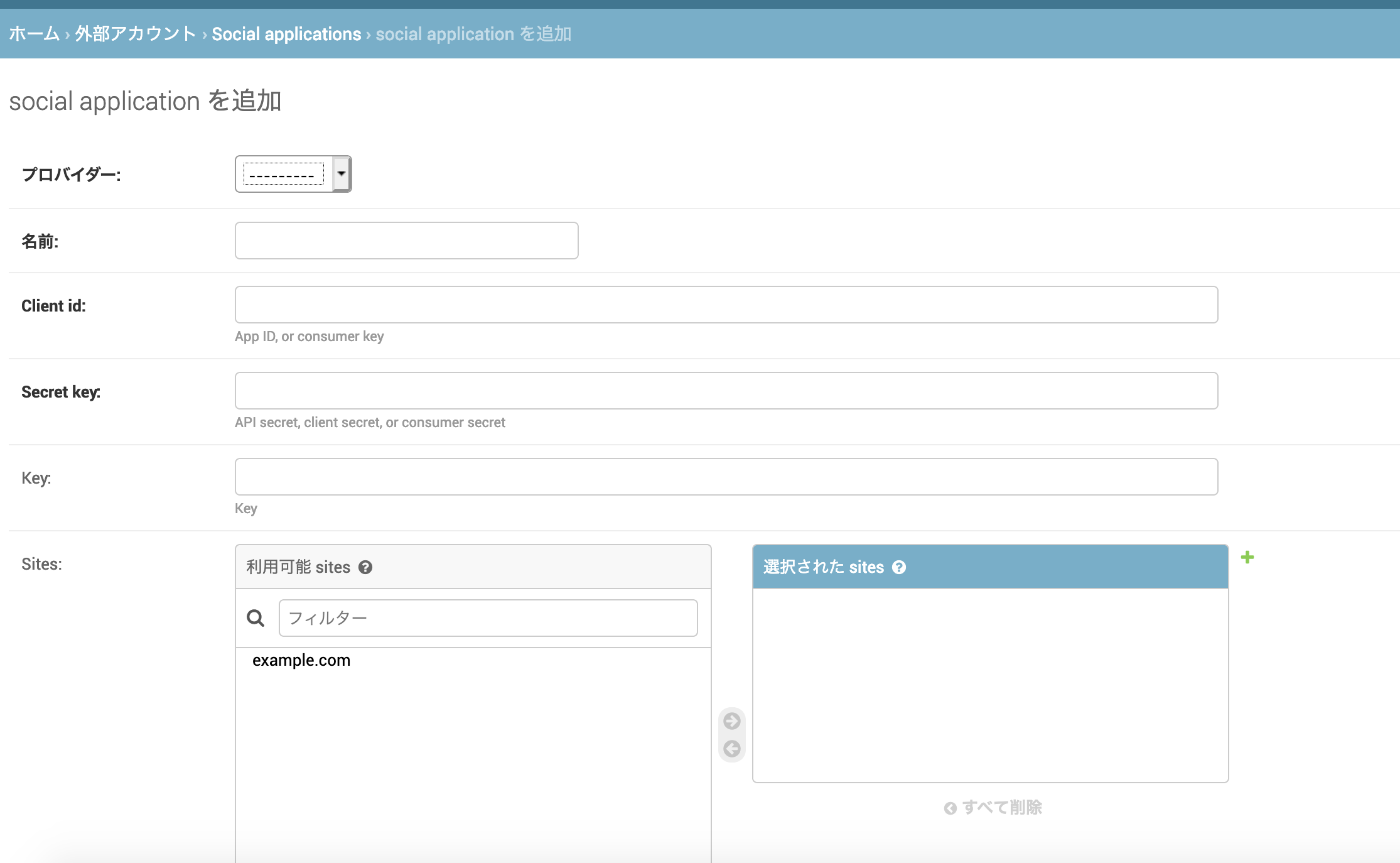

[外部アカウント]=>[Social applications]=>[social applicationを追加]を選択していくと、入力画面が現れます。プロバイダーを選択、名前(Facebookなど)、Client ID、Secret keyを入力し(Client IdとSecret keyはFacebookディベロッパーから取得)、保存します。

早速ログインを試してみる

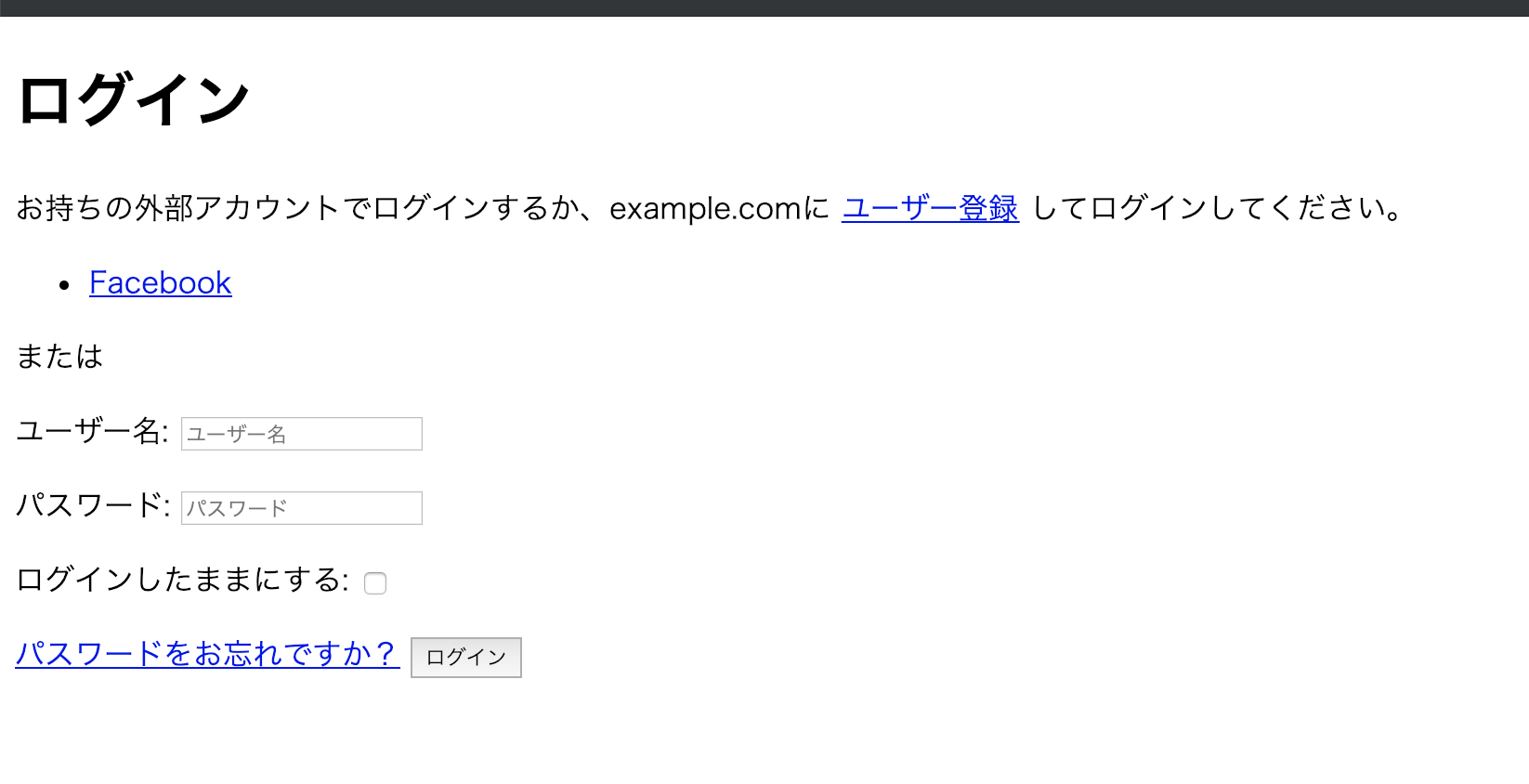

管理サイトからログアウトし、http://localhost:8000/accounts/login/ にアクセス。

ここはもちろんFacebookリンクにアクセスしましょう。

Facebook認証画面の登場です。

良い感じですね。

自分のFacebookアカウントでログインしてみましょう。自身のFacebookの名前が入り、ログインされていることができましたか?

facebookユーザー認証までは以上の流れになります。その先

実際はログアウト、パスワードリセット、アカウント削除、ユーザーモデルのアレンジや認証方法のアレンジ(メール認証など)、リダイレクト先やサイトのUIなどやることは山積みですが、これでDjangoでのfacebook認証というとっつきづらそうな課題に風穴を開けたことに間違いはありません。

ちなみに今回はfacebook認証を行いましたが、django-allauthを使えば様々なソーシャルアカウントでの認証ができます。例えば...# ... include the providers you want to enable: 'allauth.socialaccount.providers.agave', 'allauth.socialaccount.providers.amazon', 'allauth.socialaccount.providers.angellist', 'allauth.socialaccount.providers.asana', 'allauth.socialaccount.providers.auth0', 'allauth.socialaccount.providers.authentiq', 'allauth.socialaccount.providers.baidu', 'allauth.socialaccount.providers.basecamp', 'allauth.socialaccount.providers.bitbucket', 'allauth.socialaccount.providers.bitbucket_oauth2', 'allauth.socialaccount.providers.bitly', 'allauth.socialaccount.providers.cern', 'allauth.socialaccount.providers.coinbase', 'allauth.socialaccount.providers.dataporten', 'allauth.socialaccount.providers.daum', 'allauth.socialaccount.providers.digitalocean', 'allauth.socialaccount.providers.discord', 'allauth.socialaccount.providers.disqus', 'allauth.socialaccount.providers.douban', 'allauth.socialaccount.providers.draugiem', 'allauth.socialaccount.providers.dropbox', 'allauth.socialaccount.providers.dwolla', 'allauth.socialaccount.providers.edmodo', 'allauth.socialaccount.providers.eveonline', 'allauth.socialaccount.providers.evernote', 'allauth.socialaccount.providers.facebook', 'allauth.socialaccount.providers.feedly', 'allauth.socialaccount.providers.fivehundredpx', 'allauth.socialaccount.providers.flickr', 'allauth.socialaccount.providers.foursquare', 'allauth.socialaccount.providers.fxa', 'allauth.socialaccount.providers.github', 'allauth.socialaccount.providers.gitlab', 'allauth.socialaccount.providers.google', 'allauth.socialaccount.providers.hubic', 'allauth.socialaccount.providers.instagram', 'allauth.socialaccount.providers.jupyterhub', 'allauth.socialaccount.providers.kakao', 'allauth.socialaccount.providers.line', 'allauth.socialaccount.providers.linkedin', 'allauth.socialaccount.providers.linkedin_oauth2', 'allauth.socialaccount.providers.mailru', 'allauth.socialaccount.providers.mailchimp', 'allauth.socialaccount.providers.meetup', 'allauth.socialaccount.providers.naver', 'allauth.socialaccount.providers.odnoklassniki', 'allauth.socialaccount.providers.openid', 'allauth.socialaccount.providers.orcid', 'allauth.socialaccount.providers.paypal', 'allauth.socialaccount.providers.persona', 'allauth.socialaccount.providers.pinterest', 'allauth.socialaccount.providers.reddit', 'allauth.socialaccount.providers.robinhood', 'allauth.socialaccount.providers.shopify', 'allauth.socialaccount.providers.slack', 'allauth.socialaccount.providers.soundcloud', 'allauth.socialaccount.providers.spotify', 'allauth.socialaccount.providers.stackexchange', 'allauth.socialaccount.providers.steam', 'allauth.socialaccount.providers.stripe', 'allauth.socialaccount.providers.trello', 'allauth.socialaccount.providers.tumblr', 'allauth.socialaccount.providers.twentythreeandme', 'allauth.socialaccount.providers.twitch', 'allauth.socialaccount.providers.twitter', 'allauth.socialaccount.providers.untappd', 'allauth.socialaccount.providers.vimeo', 'allauth.socialaccount.providers.vimeo_oauth2', 'allauth.socialaccount.providers.vk', 'allauth.socialaccount.providers.weibo', 'allauth.socialaccount.providers.weixin', 'allauth.socialaccount.providers.windowslive', 'allauth.socialaccount.providers.xing', ... )https://django-allauth.readthedocs.io/en/latest/installation.html

(ドキュメントより)個人的にFBはあまり信頼していないので、一つのパッケージにこうした多くの他の手段が用意されているのは非常にありがたいなと思います。

ただし難点も...

https://djangopackages.org/grids/g/facebook-authentication/

これをみると

django-allauthはdevelopment statusがBetaのようです。

本番環境で使うには心許ないか。

しかしUpdatedの頻度やStars、Repo Forksの数などをみると、他に比べるとdjango-allauthは圧倒的人気を誇っているようですね。開発にかけられる工数もそれぞれだと思いますので、用途に合わせて使えるよう色々と今後勉強してみたいと思います!

- 投稿日:2019-02-09T22:51:51+09:00

【Django】Djangoで開発環境の構築から、django-allauthを使いfacebookでユーザー認証を行うところまでのTips②

Django-Facebookを使ってFacebook認証を実装

Djangoが用意しているSNSアカウント認証のパッケージはいくつもありますが(https://djangopackages.org/grids/g/facebook-authentication/ )、

一般的にDjango-Allauthが広く使われています。$pip install django-allauth .... Installing collected packages: defusedxml, python3-openid, oauthlib, urllib3, certifi, chardet, idna, requests, requests-oauthlib, django-allauth Running setup.py install for django-allauth ... done Successfully installed certifi-2018.11.29 chardet-3.0.4 defusedxml-0.5.0 django-allauth-0.38.0 idna-2.8 oauthlib-3.0.1 python3-openid-3.1.0 requests-2.21.0 requests-oauthlib-1.2.0 urllib3-1.24.1

config/settings.pyに下の最後の4行を追加しますconfig/settings.pyINSTALLED_APPS = [ 'django.contrib.admin', 'django.contrib.auth', INSTALLED_APPS = [ 'django.contrib.admin', 'django.contrib.auth', 'django.contrib.contenttypes', 'django.contrib.sessions', 'django.contrib.messages', 'django.contrib.staticfiles', 'django.contrib.sites', 'allauth', 'allauth.account', 'allauth.socialaccount', 'allauth.socialaccount.providers.facebook', ]django-allauthはsitesフレームワークの利用が必要になります。

そこでDjangoサイトを識別する為に、以下の設定を付け加えます。config/settings.pySITE_ID = 1config/urls.pyurlpatterns = [ path('admin/', admin.site.urls), path('', TemplateView.as_view(template_name='home.html'), name='home'), path('accounts/', include('allauth.urls')), ] #<=変更するFacebookディベロッパーに登録

まずはこちらのリンクから、Facebookディベロッパー登録します。

https://developers.facebook.com/アプリIDとSecret keyを取得できます。これは後ほど使います。

もし登録はしたことがあるけど自分のアプリIDとSecret keyがわからないという方は、ログイン後トップ画面の

左側のツールバーから[設定]=>[ベーシック]から調べることが可能です。続いてmigrate、runserverします。

$python manage.py migrate $python manage.py createsuperuser #管理者のユーザー名、メールアドレス、Passwordを求められる $python manage.py runserverhttp://localhost:8000/admin/ に先ほどcreatesuperuserして作成した管理者アカウントでログイン。

そしてログイン後、「サイト」にアクセスすると,

example.com というサイトができていることがわかります。管理画面トップに戻り、

[外部アカウント]=>[Social applications]=>[social applicationを追加]を選択していくと、入力画面が現れます。プロバイダーを選択、名前(Facebookなど)、Client ID、Secret keyを入力し(Client IdとSecret keyはFacebookディベロッパーから取得)、保存します。

早速ログインを試してみる

管理サイトからログアウトし、http://localhost:8000/accounts/login/ にアクセス。

ここはもちろんFacebookリンクにアクセスしましょう。

Facebook認証画面の登場です。

良い感じですね。

自分のFacebookアカウントでログインしてみましょう。自身のFacebookの名前が入り、ログインされていることができましたか?

facebookユーザー認証までは以上の流れになります。その先

実際はログアウト、パスワードリセット、アカウント削除、ユーザーモデルのアレンジや認証方法のアレンジ(メール認証など)、リダイレクト先やサイトのUIなどやることは山積みですが、これでDjangoでのfacebook認証というとっつきづらそうな課題に風穴を開けたことに間違いはありません。

ちなみに今回はfacebook認証を行いましたが、django-allauthを使えば様々なソーシャルアカウントでの認証ができます。例えば...# ... include the providers you want to enable: 'allauth.socialaccount.providers.agave', 'allauth.socialaccount.providers.amazon', 'allauth.socialaccount.providers.angellist', 'allauth.socialaccount.providers.asana', 'allauth.socialaccount.providers.auth0', 'allauth.socialaccount.providers.authentiq', 'allauth.socialaccount.providers.baidu', 'allauth.socialaccount.providers.basecamp', 'allauth.socialaccount.providers.bitbucket', 'allauth.socialaccount.providers.bitbucket_oauth2', 'allauth.socialaccount.providers.bitly', 'allauth.socialaccount.providers.cern', 'allauth.socialaccount.providers.coinbase', 'allauth.socialaccount.providers.dataporten', 'allauth.socialaccount.providers.daum', 'allauth.socialaccount.providers.digitalocean', 'allauth.socialaccount.providers.discord', 'allauth.socialaccount.providers.disqus', 'allauth.socialaccount.providers.douban', 'allauth.socialaccount.providers.draugiem', 'allauth.socialaccount.providers.dropbox', 'allauth.socialaccount.providers.dwolla', 'allauth.socialaccount.providers.edmodo', 'allauth.socialaccount.providers.eveonline', 'allauth.socialaccount.providers.evernote', 'allauth.socialaccount.providers.facebook', 'allauth.socialaccount.providers.feedly', 'allauth.socialaccount.providers.fivehundredpx', 'allauth.socialaccount.providers.flickr', 'allauth.socialaccount.providers.foursquare', 'allauth.socialaccount.providers.fxa', 'allauth.socialaccount.providers.github', 'allauth.socialaccount.providers.gitlab', 'allauth.socialaccount.providers.google', 'allauth.socialaccount.providers.hubic', 'allauth.socialaccount.providers.instagram', 'allauth.socialaccount.providers.jupyterhub', 'allauth.socialaccount.providers.kakao', 'allauth.socialaccount.providers.line', 'allauth.socialaccount.providers.linkedin', 'allauth.socialaccount.providers.linkedin_oauth2', 'allauth.socialaccount.providers.mailru', 'allauth.socialaccount.providers.mailchimp', 'allauth.socialaccount.providers.meetup', 'allauth.socialaccount.providers.naver', 'allauth.socialaccount.providers.odnoklassniki', 'allauth.socialaccount.providers.openid', 'allauth.socialaccount.providers.orcid', 'allauth.socialaccount.providers.paypal', 'allauth.socialaccount.providers.persona', 'allauth.socialaccount.providers.pinterest', 'allauth.socialaccount.providers.reddit', 'allauth.socialaccount.providers.robinhood', 'allauth.socialaccount.providers.shopify', 'allauth.socialaccount.providers.slack', 'allauth.socialaccount.providers.soundcloud', 'allauth.socialaccount.providers.spotify', 'allauth.socialaccount.providers.stackexchange', 'allauth.socialaccount.providers.steam', 'allauth.socialaccount.providers.stripe', 'allauth.socialaccount.providers.trello', 'allauth.socialaccount.providers.tumblr', 'allauth.socialaccount.providers.twentythreeandme', 'allauth.socialaccount.providers.twitch', 'allauth.socialaccount.providers.twitter', 'allauth.socialaccount.providers.untappd', 'allauth.socialaccount.providers.vimeo', 'allauth.socialaccount.providers.vimeo_oauth2', 'allauth.socialaccount.providers.vk', 'allauth.socialaccount.providers.weibo', 'allauth.socialaccount.providers.weixin', 'allauth.socialaccount.providers.windowslive', 'allauth.socialaccount.providers.xing', ... )https://django-allauth.readthedocs.io/en/latest/installation.html

(ドキュメントより)個人的にFBはあまり信頼していないので、一つのパッケージにこうした多くの他の手段が用意されているのは非常にありがたいなと思います。

ただし難点も...

https://djangopackages.org/grids/g/facebook-authentication/

これをみると

django-allauthはdevelopment statusがBetaのようです。

本番環境で使うには心許ないか。

しかしUpdatedの頻度やStars、Repo Forksの数などをみると、他に比べるとdjango-allauthは圧倒的人気を誇っているようですね。開発にかけられる工数もそれぞれだと思いますので、用途に合わせて使えるよう色々と今後勉強してみたいと思います!

- 投稿日:2019-02-09T22:41:58+09:00

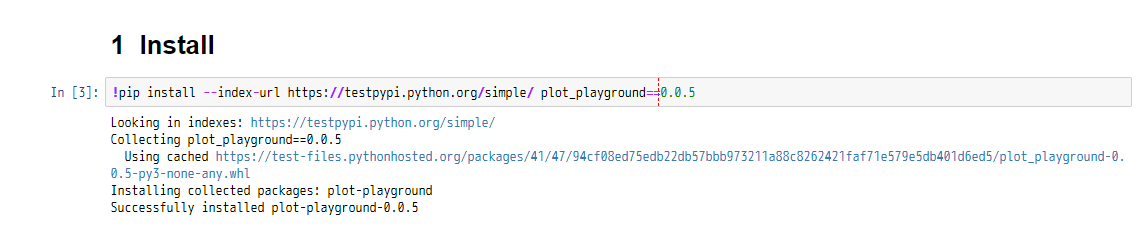

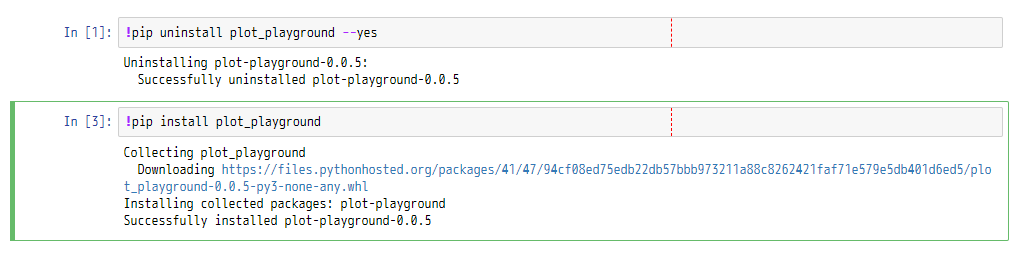

Jupyterで使える自作のプロットライブラリを作ってみたい。

Jupyter上で使えるプロットを自分で作って遊べないか試してみました。

ゴミでもなんでもアウトプットしていくべきとのことで、大したことのないものですが進めていきます。

plotlyとか既に色々選択肢がありますが、勉強目的と、自分でカスタマイズなどもできるように、車輪の再発明をしていきます。使うjsライブラリ

インタラクティブ且つ色々アニメーションさせたりも考えて、D3.jsをPython側から扱っていく方向で進めます。後は作業中は個別のモジュール単位などで実施し、定期的に全体のテストを流していく等すればテスト時間はそこまで気にならなくなりそうです。

(D3.js自体は以前記事にしているのでそちらも良ければ : SVGとD3.jsの入門まとめ)

jsライブラリの読み込みはどうやるの?

べたでjsやHTMLを書いたりする分にはIPython.displayパッケージ内の関数やクラスを使っていけばJupyter上で色々できますが、外部のjsファイルなどを対象としたい場合はどうすればいいのでしょう。

Jupyter上で、HTMLやdisplayメソッドを組み合わせてscriptタグでsrc指定したくらいだと、エラーで怒られるようです。

他の方のライブラリでマジックコマンドでJupyter上でD3.jsを扱えるようにするものがありましたが、今回はJupyter上で直接D3.jsを扱うのではなく、.pyファイルを経由する形でライブラリで色々やりたいところです。調べたところ、requirejsを使う形でJupyterで読み込めるとの記事があったため、そちらを利用する形にしました。

%%html <script> requirejs.config({ paths: { 'd3': ['https://d3js.org/d3.v4.min'], }, }); </script>※minの後に.jsといった拡張子は付けない形で指定します。

※v4のバージョンの個所は他のものを使う際には調整してください。後は、使いたいタイミングでrequire(['d3'], function(d3) {...といった記述をすることで、D3.jsがJupyter上で使えます。

%%html <svg id="test-svg" width="100" height="100"> </svg> <script> require(['d3'], function(d3) { d3.select("#test-svg") .append("rect") .attr("width", "100") .attr("height", "100") .attr("fill", "#ff0000"); }); </script>※htmlのマジックコマンドで記述したましたが、IPython.display.display関数とIPython.display.HTMLを組み合わせて、.py上から実行してもちゃんとJupyter上で表示されます。

テストどうしようか問題

フロントのテストに近いような印象ですが、Jupyter上で動作することを目的とするため、普通のバックエンド側の単体テストなどと比べると少し厄介です。

手動でのテストに頼る形でもいいのかもしれませんが、50とか100とかにプロットの種類がなってくると少ししんどい気配があります。

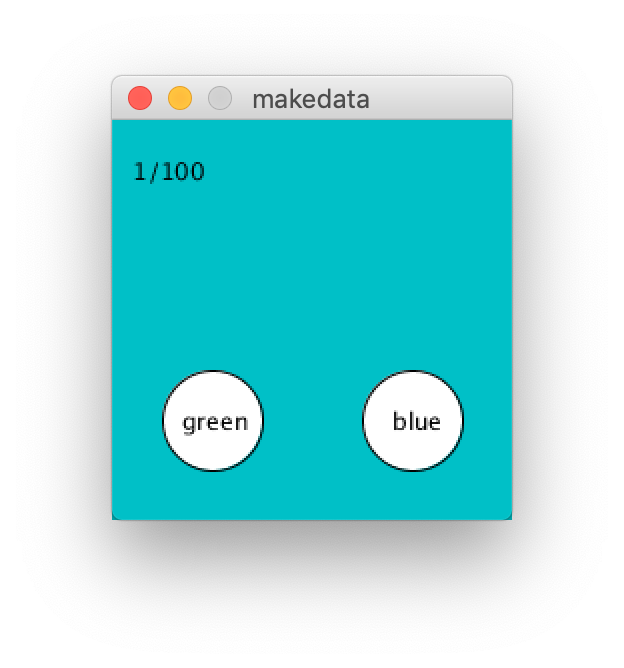

細かいアニメーションなどは目に頼る必要がありますが、それ以外のあまりテストを書く負担が重くなく、且つ書いてあると安心感が出てくる費用対効果が高そうなところはJupyterなどが絡む個所でもテストを書く形で進めます。Jupyterの起動

まずは、Jupyterを起動させないといけないため、noseのテストランナーのラッパー的なモジュールを用意しました。

そのモジュール内で、別のプロセスでJupyterを起動するようにしました。

起動コマンドの--no-browserオプションで、ブラウザを起動せずにJupyterを起動できます。後で触れますが、selenium側で別途ブラウザを立ち上げるので、ここではブラウザの起動はしない形で設定しています。

また、--portでテスト用のJupyterのポートを指定しています。通常は8888が使われ、8888が使用済みであれば8889...といった具合にポート番号が割り振られていくので、それらとテスト用のJupyterで番号が被らないように設定しています。import os import multiprocessing as mp import subprocess as sp import time ... def run_jupyter_process(): """ Start Jupyter process for testing. """ os.system( 'jupyter notebook --no-browser --port={jupyter_test_port} &'.format( jupyter_test_port=JUPYTER_TEST_PORT )) ... jupyter_process = mp.Process(target=run_jupyter_process) jupyter_process.start()また、別のプロセスにしないとJupyter起動のコマンドで処理が止まってしまう(Ctrl + CなどでJupyterを止めないと次に進まない)のでmultiprocessingモジュールを利用しています。

ただ、いつ起動が終わるのかが見えないので、起動が終わったかどうかをチェックする必要があります。以下のようなコマンドで、起動が終わって動いているJupyterの一覧が表示できるので、そのリストの中に指定したテスト用のポートのJupyterが存在するかどうかをチェックし、存在する状態になったタイミングでnoseのテストに移るようにwhile文で制御します。$ jupyter notebook list以下のようにポートやトークンなどを含めたリストが表示されます。

Currently running servers: http://localhost:8888/?token=27fc5d92e60184655a145a6ef723ff5f6349571b3cd0cb1e :: C:\Users\def is_jupyter_started(): """ Get the boolean value as to whether Jupyter for testing has been started or not. Returns ------- result : bool If it is started this function will returns True. """ out = sp.check_output( ['jupyter', 'notebook', 'list']) out = str(out) is_in = str(JUPYTER_TEST_PORT) in out if is_in: return True return False ... while not is_jupyter_started(): time.sleep(1)また、テストが終わった後に、起動したJupyterを止めないと、ポート番号がどんどんずれていったり、メモリを無駄に消費したりと好ましくありません。

アクセス時にもポート番号がずれずに固定のものだと制御が楽なので、テスト前と終わったタイミングでテスト用のポートのJupyterが起動していれば止めるようにしておきます。

以下のようなフォーマットのコマンドで任意のJupyterを止めることができます。$ jupyter notebook stop {ポート番号}def stop_jupyter(): """ Stop Jupyter of the port number used in the test. """ os.system('jupyter notebook stop {jupyter_test_port}'.format( jupyter_test_port=JUPYTER_TEST_PORT )) ... stop_jupyter() jupyter_process.terminate()テスト長くない?問題

テスト時にJupyterを起動させる都合、ちょっとテストが終わるまで長くなります。

一部のモジュールだけテストしたい、といったケースでも1分かかったりします。

仕事だと部分的なテストは3秒くらいあれば起動から終わりまで通るのでそれらと比べると少し辛いところです。

基本的にテストを流している間もぼーっとしているのは非効率なので、作業しつつ終わったら通知が来るようにしておきます。Win10環境で作業しているので、Windows 10 Toast NotificationsというPythonライブラリを使わせていただきました。

これで、テストが終わった際に画面右下に通知が表示されます。インストール :

$ pip install win10toast==0.9また、テストにはnoseライブラリを使っていますが、noseで引数に--with-xunitと--xunit-fileを指定することで、指定のパスにテストの実行結果をXMLで保存してくれるようになるようです。XML内に、テスト全体の実行件数や失敗件数、各テストの処理時間が保存されます。

XMLのパース用に、Pythonのxmlモジュールを使って値を取っていきます。import xml.etree.ElementTree as ET ... from win10toast import ToastNotifier import nose ... def run_nose_command(module_name): """ Execute the test command with the Nose library, and obtain the number of execution tests and the number of failure tests. Parameters ---------- module_name : str Name of the module to be tested. Specify in a form including a path. Omit extension specification. If an empty character is specified, all tests are targeted. Returns ------- test_num : int Number of tests executed. error_num : int Number of errors. failures_num : int Number of tests failed. """ xml_path = 'log_test.xml' nose_command = 'nosetests' if module_name != '': nose_command += ' %s' % module_name nose_command += ' --with-xunit --xunit-file={xml_path} -s -v'.format( xml_path=xml_path ) os.system(nose_command) with open(xml_path, 'r') as f: test_xml = f.read() xml_root_elem = ET.fromstring(text=test_xml) test_num = int(xml_root_elem.attrib['tests']) error_num = int(xml_root_elem.attrib['errors']) failures_num = int(xml_root_elem.attrib['failures']) return test_num, error_num, failures_num ... test_num, error_num, failures_num = run_nose_command( module_name=module_name) ... toast_msg = '----------------------------' toast_msg += '\ntest num: %s' % test_num toast_msg += '\nerror num: %s' % error_num toast_msg += '\nfailures num: %s' % failures_num toast_notifier = ToastNotifier() toast_notifier.show_toast( title='The test is completed.', msg=toast_msg, duration=5)これでテスト終了時に通知が飛んでくるようになります。音も鳴るのでよそ見していても安心。

お好みでSlackなどに調整するといいと思われます。というか、なんとなくお試しでこれ使ってみたけれど、普通にSlackでいいよね。

後は作業中は個別のモジュール単位などで実施し、定期的に全体のテストを流していく等すればテスト時間はそこまで気にならなくなりそうです。

また、テストのコマンドの引数で、Jupyterの起動をスキップするかどうかの指定を受け入れるようにも調整しました(1つの関数のみのテストなどで、Jupyterを使わない場合など)。遊びなので本格的なCI的なところまでは対応しませんが、ひとまずは個人で進めるにはこの程度で良さそうです。

(本当はPython用のlintを入れたり、Jupyterのプロセスを一度起動したら使いまわしたりした方がテストが早く終わったりで快適かと思われますが、それらは後日機会があれば少しずつ・・)seleniumでChromeのWebDriverを使う

テスト用のJupyterへのアクセスはseleniumとChromeのWebDriverを使わせていただきました。

過去、PhantomJSやらFireFoxは使ったことがありましたが、今回初のChromeです。前者二つよりも考えるべきことが少なく済んでなんだか快適です。参考にさせていただきました : Python + Selenium で Chrome の自動操作を一通り

import chromedriver_binaryとするだけでパスが通るのもシンプルでいいですね。

seleniumからJupyterのセルにスクリプトを入力できない問題

テスト時にJupyterやら起動させる点は問題がありませんでしたが、その後selenium経由でJupyterのセル内にスクリプトを入力していこうとしたところ、input周りの構造が大分複雑でうまくいきませんでした。クリックした後にseleniumのsend_keyなどだといまいちうまくいきません。どうやらtextarea関係がJupyter上では実は非表示になっているそうで・・

対策として、開く前にipynbファイルのセルの設定に直接値を設定して、それからノートのページを開くように調整しました。(テスト用であればこれだけでも十分かなと)

ただし、よく調べてみるとselenim経由でDOMを色々操作してしまえばいけそう、という情報が見つかりました。こちらの方がスマートな気がしないでもないので、後日気が向いたら調整しようと思います。

NOTE I have been successful when changing the DOM with javascript execution by making the textarea visible and then sending keys to it. (This was done by removing hidden; from the style attribute in the parent div element that it inherited from. However, I am looking for a solution which does not require altering the DOM.

python Selenium send_keys to a Jupyter notebook後は、seleniumからRUN ALLメニューなどを操作するスクリプトを書いて、アウトプットの内容を取得してテストするスクリプトを組んでひとまずはテストができそうな気配が出てきました。

アウトプットの要素のスクショがうまく取れない問題

How to take partial screenshot with Selenium WebDriver in python?

テストのためのJupyterやらseleniumなどの準備が整ったので、いざJupyter上でのD3.js経由のアウトプットの表示結果のスクショを取ってみよう・・と上記のstackoverflowの投稿を参考に進めてみたところ、なんだかスクショ領域がずれます。

なぜだろう・・と色々悩んだり調べていたところ、上記のstackoverflow内で以下のコメントを見つけました。

On MacOS (retina) there is problem that web element position in pixels dont match element position in screenshot, due to resize/ratio –

画面の比率の問題・・そういえば、タブレットで作業をしているので、150%(推奨値)に設定していたのを思い出しました。

ちょっと文字が小さい感が無きにしもですが、100%にしてみたところ正常に動作しました・・どうやら、selenium側での座標などの取得値が画面の解像度が100%ではない場合はずれてしまう模様。

てっきりJupyterのヘッダー部分などがある都合、座標がずれるのかとか考えて、非表示にする処理を追加したりしてしまいましたがそうではなかったようで・・。

環境変数的なもので、画面解像度設定のファイルを設置してもいいのですが、少し手間なので一旦100%で進めます。引数に渡したWebElement要素のスクショを取るコード(基本的にJupyter上のSVG要素を指定):

def save_target_elem_screenshot( target_elem, img_path=DEFAULT_TEST_IMG_PATH): """ Save screenshot of target element. Parameters ---------- target_elem : selenium.webdriver.remote.webelement.WebElement The WebElement for which screen shots are to be taken. img_path : str, default DEFAULT_TEST_IMG_PATH The destination path. """ driver.find_element_by_tag_name('body').send_keys( Keys.CONTROL + Keys.HOME) location_dict = target_elem.location size_dict = target_elem.size elem_x = location_dict['x'] left = location_dict['x'] top = location_dict['y'] right = location_dict['x'] + size_dict['width'] bottom = location_dict['y'] + size_dict['height'] screenshot_png = driver.get_screenshot_as_png() img = Image.open(BytesIO(screenshot_png)) img = img.crop((left, top, right, bottom)) img.save(img_path) img.close()※Jupyterの起動、seleniumの起動、Jupyterの入力のセルにテスト用のスクリプトを設定する処理、テスト用のノートを開く処理、Jupyter上のスクリプトの実行、ヘッダーと入力のセルを非表示にする処理(スクショが途切れないように)、アウトプットのSVG領域のスクショを保存する処理の流れのGIFアニメ:

一部以前使っていたJupyterの拡張機能の都合、通知の許可云々が出てきていますが、害は無いので放置します

スクショの保存結果:

ひとまずはD3.jsを経由しての四角を追加するだけのシンプルなものではありますが、このテストの流れでいけそうな気配があります。

OpenCVでの画像の比較

ヒストグラム比較

参考にさせていただきました。

スクショで取った画像のRGBのヒストグラムを比較して、ほぼ想定した通りの画像になっているのかをチェックするための処理を用意します。(将来、フォントなどの表示が少し変わっても分布の差はそこまで変わらずにテストが通る、といった状況を想定)

OpenCVのcalcHistでヒストグラムの計算、compareHistでヒストグラムの比較をします。

RGBの各チャンネルに対して実施し、それぞれの類似度の平均を取得するようにします。def compare_img_hist(img_path_1, img_path_2): """ Get the comparison result of the similarity by the histogram of the two images. This is suitable for checking whether the image is close in color. Conversely, it is not suitable for checking whether shapes are similar. Parameters ---------- img_path_1 : str The path of the first image for comparison. img_path_2 : str The path of the second image for comparison. Returns ------- similarity : float Similarity between two images. The maximum is set to 1.0, and the closer to 1.0, the higher the similarity. It is set by the mean value of the histogram of RGB channels. """ assert_img_exists(img_path=img_path_1) assert_img_exists(img_path=img_path_2) img_1 = cv2.imread(img_path_1) img_2 = cv2.imread(img_path_2) channels_list = [[0], [1], [2]] similarity_list = [] for channels in channels_list: img_1_hist = cv2.calcHist( images=[img_1], channels=channels, mask=None, histSize=[256], ranges=[0, 256] ) img_2_hist = cv2.calcHist( images=[img_2], channels=channels, mask=None, histSize=[256], ranges=[0, 256] ) similarity_unit = cv2.compareHist( H1=img_1_hist, H2=img_2_hist, method=cv2.HISTCMP_CORREL) similarity_list.append(similarity_unit) similarity = np.mean(similarity_list) return similarity試しにテストで真っ赤な画像2枚を指定して、類似度が1.0(最大)になっていることや、赤と緑の画像を比較して類似度が下がっていることを確認しました。

※注 赤と緑の画像の比較でも、青は両方とも0でそこは類似しているという判定になるので、類似度が0にはならない点に注意します。from nose.tools import assert_equal, assert_true, assert_raises, \ assert_less_equal from PIL import Image ... img = Image.new(mode='RGB', size=(50, 50), color='#ff0000') img.save(TEST_IMG_PATH_1) img.save(TEST_IMG_PATH_2) img.close() similarity = img_helper.compare_img_hist( img_path_1=TEST_IMG_PATH_1, img_path_2=TEST_IMG_PATH_2) assert_equal(similarity, 1.0) img = Image.new(mode='RGB', size=(50, 50), color='#00ff00') img.save(TEST_IMG_PATH_2) img.close() similarity = img_helper.compare_img_hist( img_path_1=TEST_IMG_PATH_1, img_path_2=TEST_IMG_PATH_2) assert_less_equal(similarity, 0.5)テストでのしきい値はそのうち様子を見て調整していくとして、これでとりあえずはエラーなんかで画像が表示されていない!とかデグレして全然違うように表示されてしまっている!といったことがチェックできます。

色ではなく形を重視して比較する方法(例えば、カラーセットの変更を加味して実装した場合のテストなど)もありますが、そちらは必要性を感じてきたら追加するようにします。実際にプロットの機能の実装を考える

ここまでが結構長かった感じですが、やっと本格的なプロットの機能を考えていきます。

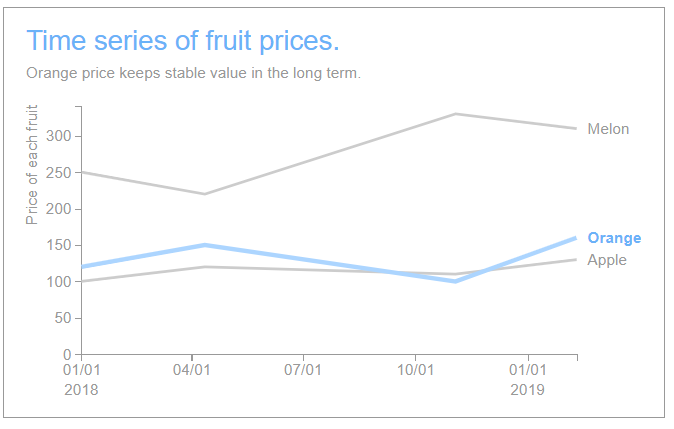

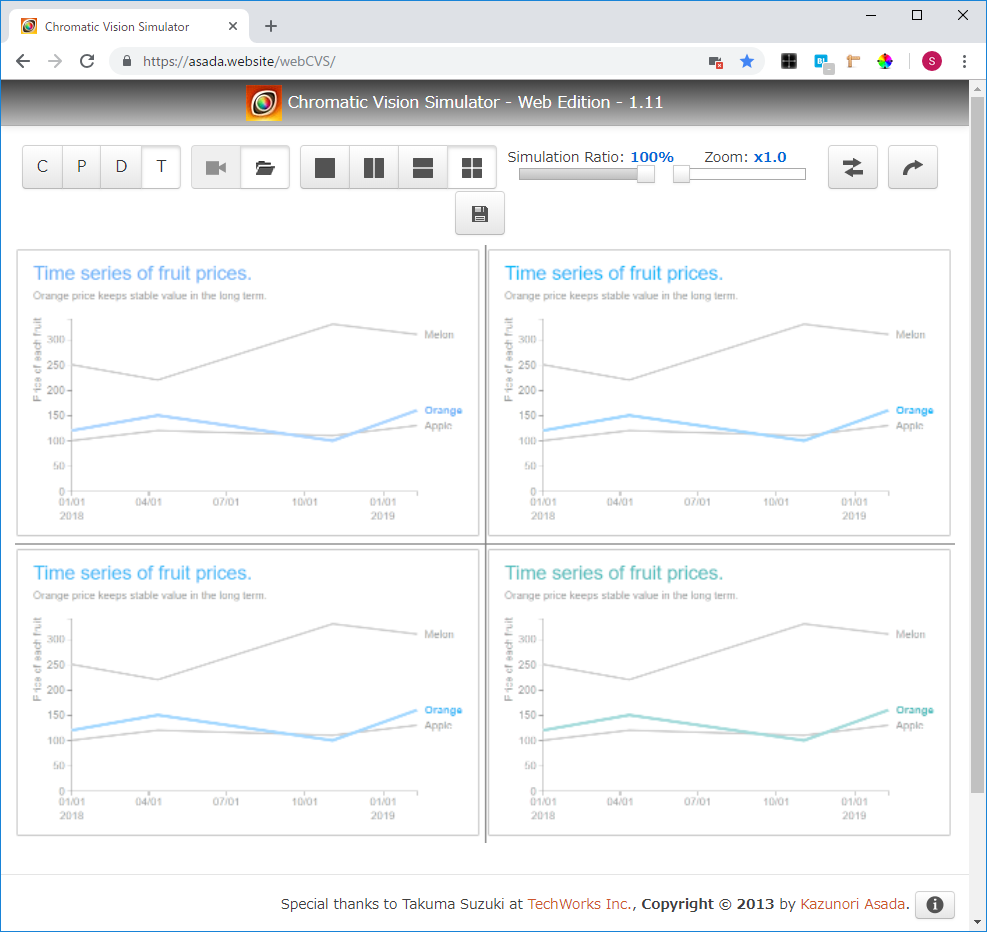

最初にどういったものを作るか・・という点ですが、シンプルなプロットであればPythonで様々な選択肢があり、それを作るのでは面白みがありません。そのため、まだ他の方で作られてなさそうな、Storytelling with Data: A Data Visualization Guide for Business Professionalsの書籍に出てくるようなプロットのPythonでの実装を考えてみます。どういったプロットかというと、「極力シンプルに」「何を伝えたいのかを極力明確に」「なるべく短時間で使えたい内容を伝える」「より効果的にするためにデザインの知見を活かす」「色弱の方でも伝わる配色」といったような、スパゲッティコードならぬスパゲッティグラフを回避するためのプロットです。

プレゼンで聞いている方への説明で短時間で伝えないといけない際など、ビジネスで役立ちます。

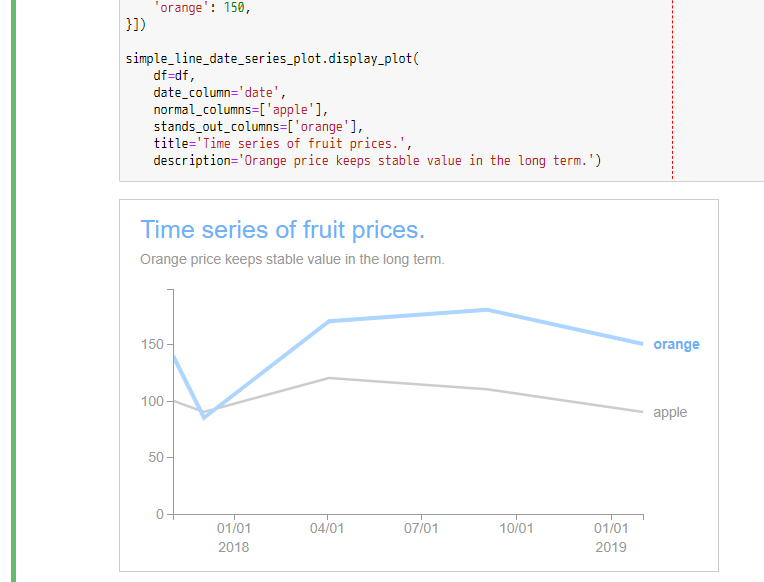

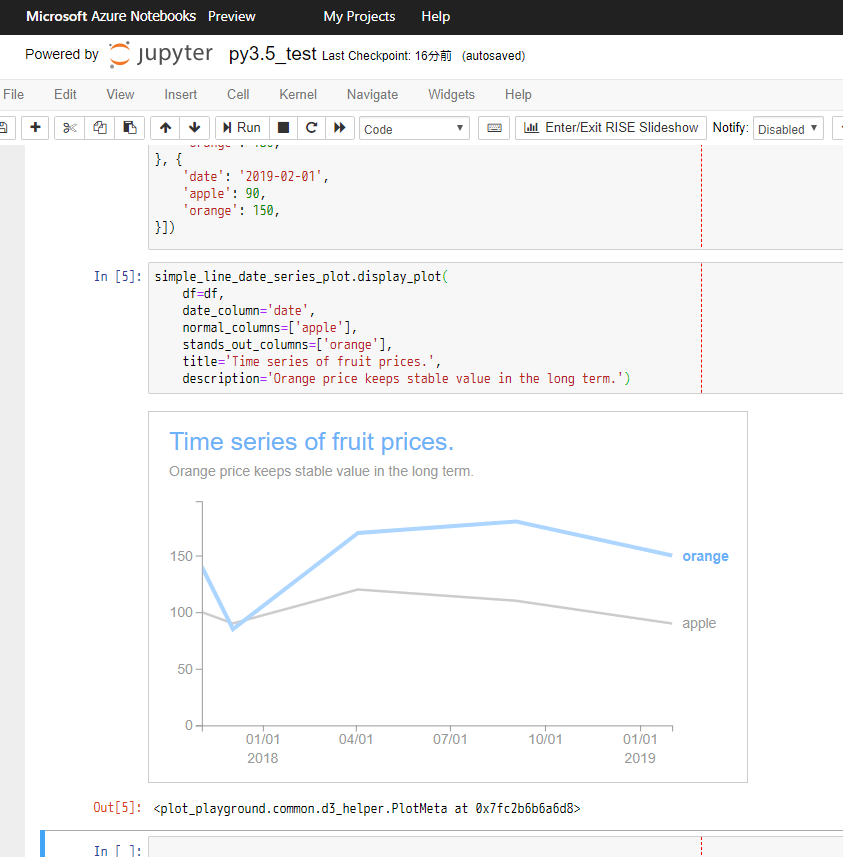

詳細は著者の方のサイトのhow I storyboardなどもご確認ください。まずは一つのラインのみ目立たせる折れ線グラフから

ベーシックなものを作っていきます。

伝えたい内容が一つの数値だけで、他の要素はあまり重要ではないようなケースで使うようなプロットを考えます。

折れ線グラフで、目立たせるものを青色、他をグレーの配色にします。(色弱の方でも区別が付きやすく、青の部分があなたが伝えたいことということが瞬時に分かるプロット)その他、以下のような点を対応します。

- 凡例を端の方でまとめる形ではなく、折れ線グラフの右端に配置するのを想定します。

- タイトル・説明文をオプションとして設定できるようにします。

- X軸の値は日付(時系列のデータ)を想定します。

- 年の表記は毎回設定する必要がないのと、X軸の表示を回転させると可読性が下がるそうなので、回転させずに年と月日で2段の表示とします。

- Y軸のラベルをオプションで設定できるようにします。(何の値なのかのラベル)

- Y軸のラベルで、前後に文字列をオプションで設定できるようにします。(例 : $や円や%記号など)

Storytelling with data for grants managersの記事に、良くない例(Before)と修正後の良い例(After)が載っています。

モックを作る

最初からJupyterへの組み込みをしながらレイアウトなどの調整をするのはしんどいため、最初はHTML単体で書いてみます。こうすることで、色々D3.jsで試行錯誤がしやすかったり、最終的にPython側から渡さないといけないパラメーターの洗い出しなどを目的とします。

こんな感じになりました。