- 投稿日:2020-12-18T23:30:28+09:00

2020年に使った技術

うなすけ氏が書いてるのを見て、自分もやってみようかなと思いました

(フロントエンド、サーバーサイドエンジニアとか関係無しに個人的なものとして)参考:https://blog.unasuke.com/2020/wrap-up-my-coding/

Application

- frontend

- Vue.js

- backend

- python, Flask

- java, Spring Boot

- other

- Docker

- Kubernetes

Vue.js, python, flaskは去年からずっと利用しているが、java, Spring Bootはつい最近触り始めた。

今のところ雰囲気でなんとかなっているが、ちゃんと勉強しとこうかなぁというところ。

Dockerも前から触っていたがkubernetesは今年になってちゃんとやった。Cloud (GCP)

- computing

- GAE (Google Application Engine)

- GKE (Google Kubernetes Engine)

- GCE (Google Compute Engine)

- Cloud Run

- firebase

- Container Registry

- DB / storage

- datastore

- BigQuery

- Cloud SQL

- realtime database

- Cloud Storage

- network

- Pub/Sub

- Cloud Endpoint

- Cloud Tasks

- Cloud Load Balancing

- Cloud DNS

- monitoring

- Stackdriver

- Cloud monitoring

- other

- Cloud workflow

- secret manager

GCPばかりいじっていた。やってるプロダクト、プロジェクトにも深く関わるのが大きな要因だが、couseraの学習コースとかでも触る機会が多かった。仕事だとGAEがメインだったが、cousera上ではGCEを作ったり消したりを繰り返していた。あとは新しく出たサービスが気になって動かしてみたものもある。

去年と比べるとネットワーク周りの設定を行ったり、GKEをガッツリさわった。

なお今年AWSは触らなかった模様。エディタの話は以下に書いたので割愛。

https://qiita.com/woody-kawagoe/items/2ab0226dd325bba5681b感想

GCPばかりやってて他に書く技術記事無えなぁと思いつつ過ごしていたけど振り返ってみると本当にGCP関連しかしてないことがわかってきた。仕事でかなり使うというのもそうだけど、新しいサービスが日々出るので気になるところであった。それとたまたま仕事でGKE触る機会ができたのも良かった。別にインフラエンジニアやってるわけではなくwebアプリ開発の方が主の業務なのだが、技術的な興味の向き先がどっちかというとインフラよりなのかもしれない。来年はkubernetes周りとかネットワークとかもっと汎用性のある記事かけたら良いなーと思う。

- 投稿日:2020-12-18T23:23:09+09:00

SQL入門(基本的なクエリの備忘録)

SQL クエリ

備忘録です。

カラムとテーブルの選択

SELECT カラム名 FROM テーブル名;

データの取得

WHERE

SELECT * FROM テーブル名 WHERE カラム名 = 要素 -- 「取得したい要素」と一致するものを検索 WHERE カラム名 LIKE %要素% -- 「取得したい要素」を含む要素を検索 WHERE NOT カラム名 = 要素 -- 「取得したい要素」と一致しないものを検索 WHERE カラム名 IS NULL -- 指定したカラムのなかでNULLのデータを検索 WHERE カラム名 IS NOT NULL -- 指定したカラムの中でNULLでないデータを検索比較演算子等

カラム名 = -- 一致 カラム名 >= -- 以上 カラム名 <= -- 以下 カラム名 < -- より大きい カラム名 > -- 未満 カラム名 LIKE -- 含む NOT カラム名 演算子 -- NOT文 カラム名 IS NULL -- NULL値である カラム名 IS NOT NULL -- NULL値でないAND / OR

WHERE 条件 AND 条件; -- AND文 WHERE 条件 OR 条件; -- OR文並び替え

ORDER BY 並び替えたいカラム 並び方; -- 並び替え文法 ASC -- 昇順 ascending order DESC -- 降順 descending order取得データ数の制限

LIMIT データの件数; -- 指定したデータの件数を取得する(numpyのheadとおなじ) /*クエリの最後に記述する*/

データベース・テーブルの作成

テーブルの作成

CREATE TABLE テーブル名( 行名1 データ型, 行名2 データ型 )データ型の種類

分類 データ型名 説明 数値型 int 整数型 ^ decimal(桁数) 固定長小数型 ^ money 通貨 ^ float 浮動小数点数値 文字列型 char(文字数), nchar(文字数) 固定長文字列型(~8000字) ^ varchar,nvarchar 可変長文字列型(~8000字) ^ text,ntext 可変長文字列型(~10億文字) 日付型 time hh ss

^ date YYYY-MM-DD ^ datetime YYYY-MM-DD hh ss

データの追加・更新・削除

データの追加

INSERT INTO テーブル名 -- 操作するテーブルを指定 (列名1,列名2,列名3) -- 操作する列を指定 VALUES (値1,値2,値3); -- 追加する値を入力データの更新(既に登録されているデータを新しいものに置き換える)

UPDATE テーブル名 SET 列名1 = 値1, 列名2 = 値2, 列名3 = 値3 --更新する値を入力 WHERE 条件 -- 更新する場所の条件を指定行の削除

DELETE FROM テーブル名 WHERE 条件 -- 指定した条件を満たす行を削除する列の追加・削除

ALTER TABLE テーブル名 ADD 列名 データ型 初期値 --列の追加 ALTER TABLE テーブル名 DROP COLUMN 列名 -- 列の削除 ALTER TABLE テーブル名 ALTER COLUMN 列名 データ型 -- 指定した列のデータ型の変更

データの加工

重複する要素を省く

/*指定したカラムから重複をのぞいて計算する*/ SELECT DISTINCT(カラム名) FROM テーブル名;計算を実行する

SELECT カラムⅠ,カラムⅡ*5 -- カラムⅠと、カラムⅡに5を掛けた値を取得

python(SQLiteの使い方)

モジュールのインポート

import sqlite3データベースとの接続

conn = sqlite3.connect("データベース.db") # データベースファイルと接続 c = conn.cursor() # カーソルオブジェクトの作成クエリの実行

c.execute(''' クエリ ''') # クエリの実行データベースとの切断

conn.close() # 切断を怠るとデータベースにロックがかかってしまう。

- 投稿日:2020-12-18T23:11:01+09:00

LeetCodeに毎日挑戦してみた 118. Pascal's Triangle(Python、Go)

Leetcodeとは

leetcode.com

ソフトウェア開発職のコーディング面接の練習といえばこれらしいです。

合計1500問以上のコーデイング問題が投稿されていて、実際の面接でも同じ問題が出されることは多いらしいとのことです。golang入門+アルゴリズム脳の強化のためにgoとPythonで解いていこうと思います。(Pythonは弱弱だが経験あり)

28問目(問題118)

118. Pascal's Triangle

問題内容

Given a non-negative integer numRows, generate the first numRows of Pascal's triangle.

(日本語訳)

負でない整数numRowsが与えられた場合、 パスカルの三角形の最初のnumRowsを生成します。

In Pascal's triangle, each number is the sum of the two numbers directly above it.Example:

Input: 5 Output: [ [1], [1,1], [1,2,1], [1,3,3,1], [1,4,6,4,1] ]考え方

空の配列を作成し、数字の数だけfor分を回します

ループ内、appendでその数に応じた[1]の要素を追加します

左端、右端は1なのでそれを除いた範囲で上の階層を参考に値を代入していきます

最終的に作成したlistsを戻り値とします

解答コード

class Solution: def generate(self, numRows): lists = [] for i in range(numRows): lists.append([1]*(i+1)) if i>1 : for j in range(1,i): lists[i][j]=lists[i-1][j-1]+lists[i-1][j] return lists

- Goでも書いてみます!

func generate(numRows int) [][]int { answer := make([][]int, numRows) for i := 0; i < numRows; i += 1 { a := make([]int, i+1) // add ones a[0], a[i] = 1, 1 if i > 1 { for j := 1; j <= i/2; j += 1 { a[j] = answer[i-1][j-1] + answer[i-1][j] a[len(a)-1-j] = a[j] } } answer[i] = a } return answer }

- 投稿日:2020-12-18T23:05:24+09:00

ミツバサンコーワ製バイク用ドラレコEDR-21で撮影した動画ファイル(30秒毎、0.5秒の重複あり)をpythonを使ってうまく結合する

はじめに

この記事はここのアドベントカレンダーのやつです。

6月からバイクを始めました。免許も取ったばかりなので安全運転を心がけたいです。

このところあおり運転に関するニュースもよく聞きますので、自衛のためにもバイク用のドラレコを取り付けました。

ミツバサンコーワ MITSUBA バイク専用ドライブレコーダー EDR-21 前後2カメラ EDR-21

前後2カメラで、162°の超広角、暗いところも強く、256GBのSDカードも対応するいい感じのやつです。購入時点で23000円くらいだったと思います。バイクショップとかで購入&取付をすると、工賃含めて4〜5万円くらいになりそうなので、Amazonで購入して自分で取り付けました。

さて、このドラレコで撮影した動画はスマホ経由でも見ることができますし、SDカードをPCにつなげて直接見ることもできるのですが、30秒毎にファイルが細切れに保存される仕様となっており、結構扱いにくいです。

さらに、ファイル間の前後0.5秒程度が重複して保存されており、1本に結合しようとしたらこの重複した0.5秒をカットしないとキレイにつながらず、とてもめんどくさいことになります。重複分を考慮してキレイにつなげようとすると、こんな感じにしないといけなく手動で30秒毎にこの編集するのは手間がかかります。

動画を1本に結合して何をするわけでもないですが、現時点でいい方法も見つからなかったので、お勉強も兼ねてpythonでやってみることにしました。

概要

ドラレコの映像には音声も乗っているので、映像と音声両方を0.5秒カットしてつなげるイメージになるでしょう。pythonでやるには、映像と音声同時に編集するのは難しそうなので、別々に編集する必要がありそうです。

使用するソフトウェア、ライブラリはこちらにしました。

- 映像と音声の分離・統合、動画エンコード:ffmpeg(Pythonからsubprocess.runで実行)

- 映像の0.5秒分カット&結合:opencv

- 音声の0.5秒分カット&結合:pydub

実装

準備

ドラレコ動画のファイルはどのように作成されているのかみてみましょう。

フロント/リアカメラ毎に、撮影開始日時、30秒動画の開始日時、をファイル名に保持しているようです。(N/Eは……とりあえず無視しておきます。まあ大丈夫でしょう)

実装イメージ

プログラム的には、カメラ毎×撮影開始日時単位にグルーピングして、動画開始日時順になるように塊を作って、塊毎に以下の処理をする感じで処理していくこととします。

- 30秒動画を映像と音声に分離

- 映像と音声のお尻0.5秒をカット

- つなげる

- 全部つながったら、映像と音声をくっつけて動画として再エンコード

実装

mitsuba.py# -*- coding: utf-8 -*- import os import shutil import cv2 import glob import subprocess from pydub import AudioSegment from collections import defaultdict from tqdm import tqdm, trange from multiprocessing import Pool,Process, Queue, TimeoutError from queue import Empty DUP_FRAME = 14 # multi processing WORKERS = 4 TIMEOUT = 10 def comb_movie(movie_files, out_path, num): # 作成済みならスキップ if os.path.exists(os.path.join("out",out_path)): return # 形式はmp4 fourcc = cv2.VideoWriter_fourcc('m', 'p', '4', 'v') #動画情報の取得 movie = cv2.VideoCapture(movie_files[0]) fps = movie.get(cv2.CAP_PROP_FPS) height = movie.get(cv2.CAP_PROP_FRAME_HEIGHT) width = movie.get(cv2.CAP_PROP_FRAME_WIDTH) # 出力先のファイルを開く out = cv2.VideoWriter(f"tmp/video_{num:02}.mp4", int(fourcc), fps, (int(width), int(height))) audio_merged = None for movies in movie_files: # 動画ファイルの読み込み,引数はビデオファイルのパス movie = cv2.VideoCapture(movies) count = movie.get(cv2.CAP_PROP_FRAME_COUNT) frames = [] if movie.isOpened() == False: # 正常に動画ファイルを読み込めたか確認 continue for _ in range(int(count)): ret, tmp_f = movie.read() # read():1コマ分のキャプチャ画像データを読み込む if ret: frames.append(tmp_f) # 読み込んだフレームを書き込み for frame in frames[:-DUP_FRAME]: out.write(frame) command = f"ffmpeg -y -i {movies} -vn -loglevel quiet tmp/audio_{num:02}.wav" subprocess.run(command, shell=True) audio_tmp = AudioSegment.from_file(f"tmp/audio_{num:02}.wav", format="wav") audio_tmp = audio_tmp[:int((count-DUP_FRAME)/fps*1000)] if audio_merged is None: audio_merged = audio_tmp else: audio_merged += audio_tmp # 結合した音声書き出し audio_merged.export(f"tmp/audio_merged_{num:02}.wav", format="wav") out.release() # 動画と音声結合 vf = "" #ビデオフィルタはお好みで 例)ややソフト・彩度アップ・ノイズ除去の場合 "-vf smartblur=lr=1:ls=1:lt=0:cr=-0.9:cs=-2:ct=-31,eq=brightness=-0.06:saturation=1.4,hqdn3d,pp=ac" # 高速なエンコーダに対応していればお好みで 例)h264_videotoolbox, libx264, h264_nvenc cv = f"-c:v libx264" # ビットレートは解像度に応じて固定にしています。 if height == 1080: # FHD bv = f"-b:v 11m" elif height == 720: # HD bv = f"-b:v 6m" else: # VGA bv = f"-b:v 3m" loglevel = "-loglevel quiet" command = f"ffmpeg -y -i tmp/video_{num:02}.mp4 -i tmp/audio_merged_{num:02}.wav {cv} {bv} {vf} -c:a aac {loglevel} out/{out_path}" subprocess.run(command, shell=True) def wrapper(args): comb_movie(*args) if __name__ == '__main__': os.makedirs("./tmp", exist_ok=True) os.makedirs("./out", exist_ok=True) # ディレクトリ内の動画を:フロント・リアカメラごと、撮影開始時間ごとにまとめる files_dict = defaultdict(list) for f in glob.glob("./in/*.MP4"): files_dict["_".join(f.split("/")[-1].split("_")[:2])].append(f) data = [] for i, (key_name, files_list) in enumerate(files_dict.items()): data.append((sorted(files_list), key_name+".mp4", i)) p = Pool(WORKERS) with tqdm(total=len(data)) as t: for _ in p.imap_unordered(wrapper, data): t.update(1) # tmp 削除 shutil.rmtree('./tmp/')補足

ソースコードはGithubでも公開しております。

※YouTube にサンプル動画上げました

- inフォルダにドラレコの生動画を入れておきます。

- 実行するとプログレスバーが表示されます。(本当はもう少し細かく表示したい)

- outフォルダに結合した動画ファイルが出来上がります。

DUP_FRAME = 14

重複しているフレーム数なので変更不要です。(動画が28fps:28フレーム/s × 0.5s = 14フレーム)WORKERS = 4

並列処理をして速くするオプションで、並列実行数を指定できます。環境に応じて変更してみてください。ビデオフィルタはお好みで

元動画は(ドラレコなので)シャープネスがややきつい感じなので、ソフトにしてみたり色々フィルタを設定できます。詳細はffmpegのフィルタで調べてみてください。高速なエンコーダに対応していればお好みで

- libx264:大体どの環境でも使えます

- h264_videotoolbox:mac用。libx264より数倍速いはず。

- h264_nvenc:linux用(windowsもいけるかな?)libx264より数倍速いはず。ビットレート

お好みですが、元の動画がそれほどキレイじゃないのでビットレート上げてもさほど効果はないかもおわりに

GoPro8を買っちゃったんですが、まあキレイです。ドラレコはドラレコとして使って、車載動画はGoProで取るほうが良さそうです。

- 投稿日:2020-12-18T22:59:41+09:00

PythonよりカッコいいElixirでラズパイ

本記事は「Raspberry Pi Advent Calendar 2020」の22日目です。

昨日は@shion21さんのiPhoneからラズパイにミラーリング!RPiPlayの使い方でした。

はじめに

2ヶ月前にラズパイを始めたとき、僕はプログラミング言語としては、Elixirを選びました。単にElixirの機能と文法が好きで、それをIoTにも使用したかったからです。一般的にはCやPythonが使用されることが多いようです。その点でElixirでラズパイをするのには不安な要素がありましたが、それが取り越し苦労だったという話です。

Elixir(えりくさ)言語とNerves(なあぶす)フレームワーク

Elixirは耐障害性、高い並列性能で長年実績のあるErlangの上に実装されたプログラミング言語で、最近ではWhatsAppなどの世界中のメッセージアプリ、チャットアプリ等でも使用されており、その性能に改めて注目が集まっていると聞きます。そのElixirをラズパイで使えるようにしてくれるNerves(なあぶす)というIoTフレームワークがあると聞き、勉強を始めたわけです。僕にとってPythonよりElixirのほうがモダンでカッコよく、Elixirを使わない理由はありません。

Nervesについて詳しくは@takasehidekiさんの「Slideshare:ElixirでIoT!?ナウでヤングでcoolなNervesフレームワーク」がわかりやすいです。また、「NervesJP」というコミュニティがあり勉強会等が実施されています。僕はNerves JPでNervesについて学んでます。

一瞬不安になったこと

世の中にあるほとんどのラズパイ情報がCかPythonを使用する前提で書かれているため、新しいことを学ぶ際には戸惑いました。例えば、先日LCDディスプレイに「Hello」と表示される練習をしようとしましたが、Elixirの資料がなかなか見つかりませんでした。ほとんどがCかPythonの既存ライブラリを使用してLCDを操作するというものでした。

大事なことは通信プロトコルと製品のデータシート

しばらく辛抱強く調査と勉強をしていると、あることに気づきました。上述のCかPythonライブラリの中身はLCDのデータシートに書かれたとおりの手順をコードにしただけで大した内容ではないと。言語がなにであろうと関係ないのですね。本当に重要なのは、パラレル通信vsシリアル通信、I2C、SPI等の通信プロトコルの基礎を学ぶことと製品のデータシートを自分の目でよく読み、分かる範囲で理解する努力をすることという結論になりました。

IoTでは最終的にハードウェアとやり取りをすることが多いと思います。その部分に関してはI2C、SPI等のシリアル通信さえできればプログラミング言語は関係がないのですね。素人の僕でも概要は理解できたので、しっかり読めば誰でもある程度の操作は(ライブラリに頼らなくても)自分でできると思います。

データシートを読まずに誰かの作ったライブラリをさがすことしか考えていなかったのが間違いでした。使える既存のライブラリがあるに越したことはないですが、いずれにしても通信プロトコルとデータシートについては理解が必要だと思います。

さいごに

いい経験になりました。別にPythonでなくても、もっとカッコいい言語で自由にラズパイを楽しめるのですね。データシートさえ読めば、特にライブラリがなくてもできる場合があることがわかり、スッキリしました。結果として自作のライブラリもできました。

僕がElixirでLCDを操作した成果は一般公開しているので、みなさんにもどんどんElixirとNervesを楽しんでもらえればと思います。

明日は@sho7650さんです。

- 投稿日:2020-12-18T22:45:45+09:00

国会会議録検索システムAPIを使って国会発言をJSONで取得しCSV出力する

はじめに

政治の世界ってわかりにくいですよね。日々揚げ足取りみたいな議論が行われている様子や失言した議員さんなどがニュースに取り上げられがちですが、実際には様々な議論が交わされています(きっと)。

そんな議論の内容、議事録データを国立国会図書館がAPIで提供してくれていて、政治のオープン化やデータ解析の題材としてとても有用だと感じました。本記事では、そのデータをJSON形式で取得してCSV出力するPythonプログラムを作成したのでそちらを紹介します。

国会議事録APIの利用例と本記事の要点について

国会会議録検索システムAPIの公式説明を抜粋すると下記のように紹介されています。

「国会会議録検索システム」は、第1回国会(昭和22(1947)年5月開会)以降の国会会議録を検索・閲覧することができるデータベースです。国立国会図書館が、衆議院・参議院と共同で提供しています。

実はこの記事執筆のちょうど1年ほど前に、別の方がQiitaで同様の記事を書いてくださっています。この中で、国会会議録検索システムについての説明や、取得したデータの活用例を紹介されていますので是非そちらもご参照ください。

一方、その記事中で当該APIの課題として「APIのレスポンスがJSON形式はなくXML形式のみ」といった点が挙げられているのですが、おそらく2020年にAPIの仕様が改善されたのかJSONでのデータ取得ができるようになっていたので、二番煎じながらJSONデータで取得するケースを紹介させていただく次第です。

国会議事録APIからのデータ取得プログラム

私の実行環境 >> OS: macOS Big Sur / Python 3.6.6

KokkaiSpeech.pyimport requests import time import json import sys import csv import re #ベースとなるURL base_url = "https://kokkai.ndl.go.jp/api/speech" #URLパラメータ用の辞書を空の状態で用意し、後から順次格納する。01はヒット総数の確認用、02はデータ取得用。 params_01 = {} params_02 = {} #パラメータを対話的に入力する text_input = input('検索する文字列を入力(Enterキーでスキップ) >> ') if text_input != "": params_01['any'] = str(text_input) params_02['any'] = str(text_input) else: pass speaker_input = input('検索する発言者名を入力(Enterキーでスキップ) >> ') if speaker_input != "": params_01['speaker'] = str(speaker_input) params_02['speaker'] = str(speaker_input) else: pass from_input = input('開始日を入力 (e.g. 2020-09-01) >> ') if re.match(r'[0-9]{4}-[0-1][0-9]-[0-3][0-9]', from_input): #正規表現によるパターンマッチングにて入力値が有効か判定 params_01['from'] = str(from_input) params_02['from'] = str(from_input) else: params_01['from'] = "2020-09-01" params_02['from'] = "2020-09-01" print("'From' date is set to 2020-09-01 due to invalid input") until_input = input('終了日を入力 (e.g. 2020-11-30) >> ') if re.match(r'[0-9]{4}-[0-1][0-9]-[0-3][0-9]', until_input): #正規表現によるパターンマッチングにて入力値が有効か判定 params_01['until'] = str(until_input) params_02['until'] = str(until_input) else: params_01['until'] = "2020-09-30" params_02['until'] = "2020-09-30" print("'Until' date is set to 2020-09-30 due to invalid input") params_01['maximumRecords'] = 1 params_01['recordPacking'] = "json" response_01 = requests.get(base_url, params_01) #URLのパラメータをエンコードしてAPIへリクエスト jsonData_01 = response_01.json() #APIからのレスポンスをJSON形式で取得 #レスポンスに含まれているヒット件数を確認(レスポンスのJSONにレコード数の項目がない場合はクエリに問題ありと判断しエラー終了) try: total_num = jsonData_01["numberOfRecords"] except: print("クエリエラーにより取得できませんでした。") sys.exit() #件数を表示し、データ取得を続行するか確認をとる next_input = input("検索結果は " + str(total_num) + "件です。\nキャンセルする場合は 1 を、データを取得するにはEnterキーまたはその他を押してください。 >> ") if next_input == "1": print('プログラムをキャンセルしました') sys.exit() else: pass max_return = 100 #発言内容は一回のリクエストにつき100件まで取得可能なため、その上限値を取得件数として設定 pages = (int(total_num) // int(max_return)) + 1 #ヒットした全件を取得するために何回リクエストを繰り返すか算定 #全件取得用のパラメータを設定 params_02['maximumRecords'] = max_return params_02['recordPacking'] = "json" Records = [] #取得データを格納するための空リストを用意 #全件取得するためのループ処理 i = 0 while i < pages: i_startRecord = 1 + (i * int(max_return)) params_02['startRecord'] = i_startRecord response_02 = requests.get(base_url, params_02) jsonData_02 = response_02.json() #JSONデータ内の各発言データから必要項目を指定してリストに格納する for list in jsonData_02['speechRecord']: list_id = list['speechID'] list_kind = list['imageKind'] list_house = list['nameOfHouse'] list_topic = list['nameOfMeeting'] list_issue = list['issue'] list_date = list['date'] list_order = list['speechOrder'] list_speaker = list['speaker'] list_group = list['speakerGroup'] list_position = list['speakerPosition'] list_role = list['speakerRole'] list_speech = list['speech'].replace('\r\n', ' ').replace('\n', ' ') #発言内容の文中には改行コードが含まれるため、これを半角スペースに置換 list_url01 = list['speechURL'] list_url02 = list['meetingURL'] Records.append([list_id, list_kind, list_house, list_topic, list_issue, list_date, list_order, list_speaker, list_group, list_position, list_role, list_speech, list_url01, list_url02]) sys.stdout.write("\r%d/%d is done." % (i+1, pages)) #進捗状況を表示する i += 1 time.sleep(1) #リクエスト1回ごとに若干時間をあけてAPI側への負荷を軽減する #CSVへの書き出し with open("kokkai_speech_" + str(total_num) + ".csv", 'w', newline='') as f: csvwriter = csv.writer(f, delimiter=',', quotechar='"', quoting=csv.QUOTE_NONNUMERIC) #CSVの書き出し方式を適宜指定 csvwriter.writerow(['発言ID', '種別', '院名', '会議名', '号数', '日付', '発言番号', '発言者名', '発言者所属会派', '発言者肩書き', '発言者役割', '発言内容', '発言URL', '会議録URL']) for record in Records: csvwriter.writerow(record)解説

上記のコード内コメントでほとんど解説を入れていますが、ポイントとしては下記となります。基本的には、API側に過剰な負荷をかけないような作法を心掛けて構成しています。

- コンソール上で対話的に検索クエリを入力していく形にしている。

- 検索クエリは発言内容の文字列や発言者名、期間を指定可能。必要なものを入力し不要なものはスキップできる。なお、期間のクエリをスキップした場合やそこに日付として不適な文字列が入った場合は、2020年9月の期間が設定されるようにプログラム上で条件分岐している。

- APIの仕様上、1回のリクエストで発言データは100件までしか取得できないので、まずは1件のみのリクエストを投げてそのレスポンスから検索クエリでのヒット総件数を確認し、その後に必要回数リクエストを繰り返してヒットした全件を取得する。

- 検索クエリでのヒット総件数を表示した時点でデータ取得をキャンセルできるようにした(検索結果が想定より多すぎる、少なすぎるといった際に無駄なデータ取得をしないように配慮)。

- プログラムの過程でAPIに繰り返しリクエストする際、API側への負荷軽減のため若干のインターバルを入れる。

コンソール上での動作例

例として、「宇宙」を含む今年の国会発言を取得してみましょう。

下記の要領でPythonコードを実行すると、コンソール上で検索文字列や検索開始日、終了日などの入力が順次求められます。必要なものは入力し、不要であればスキップします。

検索文字列は半角スペース区切りでOR検索が出来たりしますが、細かい仕様は当該APIの公式サイトをご覧ください。

その後は検索結果の件数が表示されるので、Enterキーなどを押して処理を進めます。

今回の例では268件が該当したので、3回に分けてプログラムが自動でリクエストを投げます。この進捗状況もコンソール上に表示されます。shellpython KokkaiSpeech.py 検索する文字列を入力(Enterキーでスキップ) >> 宇宙 検索する発言者名を入力(Enterキーでスキップ) >> 開始日を入力 (e.g. 2020-09-01) >> 2020-01-01 終了日を入力 (e.g. 2020-11-30) >> 2020-12-15 検索結果は 268件です。 キャンセルする場合は 1 を、データを取得するにはEnterキーまたはその他を押してください。 >> 3/3 is done.処理が終了したら、プログラムがあるフォルダに「kokkai_speech_268.csv」という名称のCSVファイルが出力されます。

おわりに

私も技術的にまだまだ勉強中の身ですが、APIを介したJSON形式でのデータ取得は一般的によく実施されるケースだと思いますので、そうした実務においても参考になれば幸いです。

また、本記事で紹介した私のプログラムは「発言内容」単位のものですが、当該APIでは「会議」単位での取得も可能になっていますので、そのあたりは適宜補正してお使いください。その際は、APIサーバ側に極端な負荷をかけないようご留意ください。

こうした議事録を文字起こしして配信いただいている国会図書館や関係者の方々に感謝しつつ、政治のオープン化、そしてより良い社会作りに役立てていきたいですね。

- 投稿日:2020-12-18T22:36:33+09:00

はじめての Intel Open VINO

はじめに

この記事は、シスコシステムズ合同会社の同士による Cisco Systems Japan Advent Calendar 2020 の 20 日目として投稿しています。

そもそも Intel OpenVINO™(以下OpenVINO)って何?Cisco とどんな関係があるの?という疑問もあると思いますのでそのあたりも含めてご紹介しようと思います。この記事でできるようになること

- 機械学習による画像認識の流れがわかる

- Intel OpenVINO™とは何かがわかる

- Intel OpenVINO™の利用方法がわかる

- Intel OpenVINO™を利用して基本的な物体認識ができる

- 物体認識に必要なモデルの利用方法がわかる

- モデルを組み合わせた複合的な物体認識ができる

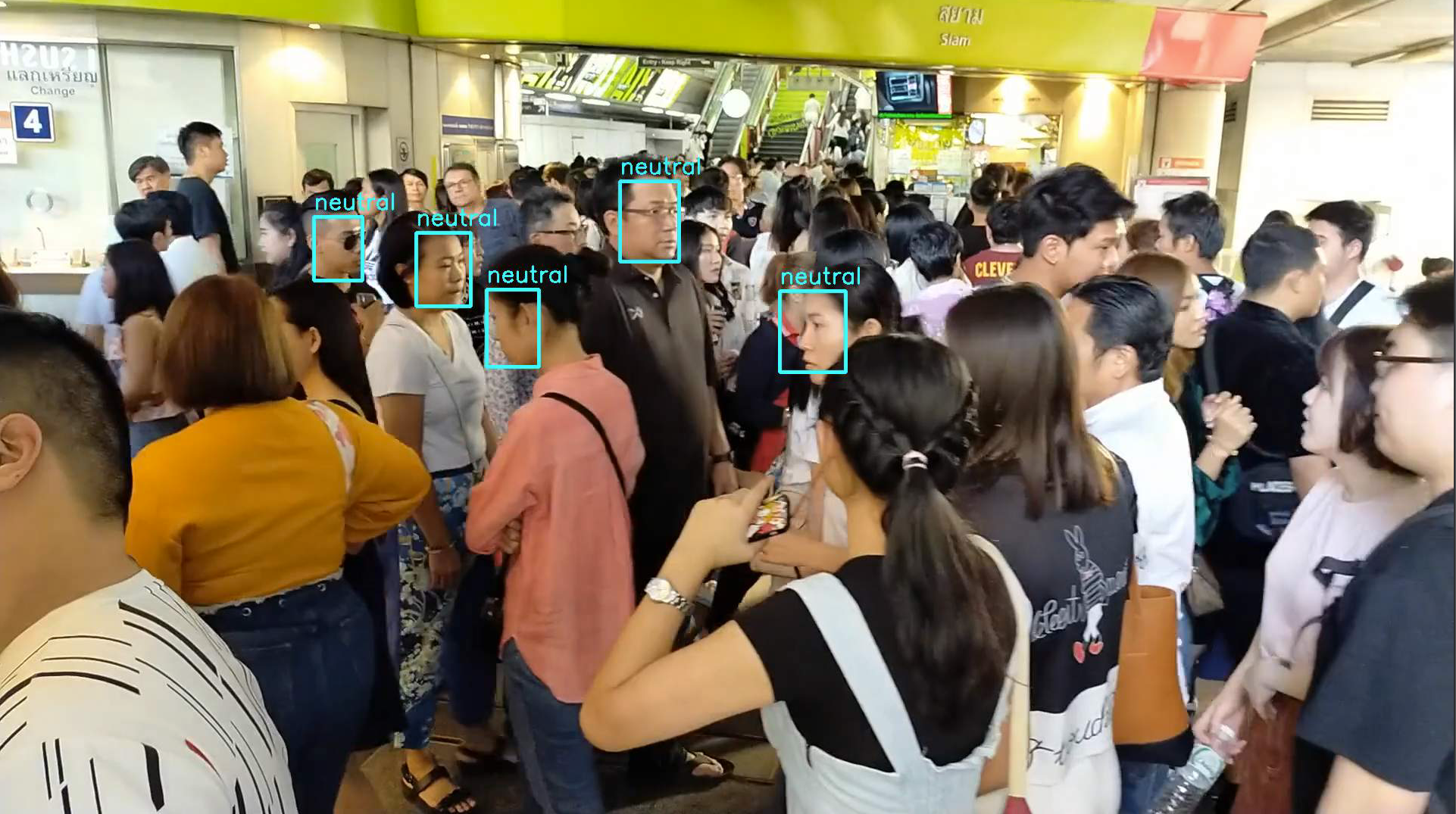

最終的にこんなことができます

Intel OpenVINO™ とは?

公式ページから

OpenVINO™ ツールキットは、インテル・アーキテクチャーの CPU、内蔵 GPU、インテル® FPGA、インテル® Movidius™ ビジョン・プロセッシング・ユニット (VPU) といった、インテルが 提供するさまざまなハードウェアでディープラーニング推論をより高速に実行するためのソフトウェア開発環境 / ライブラリー・スイートです。

開発者はツールキットに含まれるモデル・オプティマイザーを使用して、業界標準の DL フレームワークで作成した学習済みモデルデータを、さまざまなインテルのハードウェア上で動作するように最適化を行い、OpenVINO™ ツールキットの推論エンジンで使用する中間表現フォーマット (IR) に変換します。推論エンジンは CPU、内蔵 GPU、FPGA、VPU それぞれの性能を最大限に引き出すライブラリーで構成されています。

https://www.intel.co.jp/content/www/jp/ja/internet-of-things/solution-briefs/openvino-toolkit-essential-brief.html初めての方にはなんのことだろうという感じだと思いますので、詳しく解説していきます。

まず、そもそも機械学習による画像認識とはどういう流れで行われるのでしょうか。

主に機械学習は上記のようにモデルの作成とモデルの運用という部分に分割されます。

そして、実際にこのモデルを使用して推論処理を行うことにより様々なアプリケーションが実装されています。モデルを作成する際にもCPUやGPUなどのコンピューティングリソースは必要になりますが、学習するときほどではないにせよモデルを使用して推論する際にもコンピューティングリソースは必要になります。これまでは組み込み系のハードウェア、例えば監視カメラなどではコンピューティングリソースの制限などから推論処理をするためにはそれなりの場所と電力が必要でした。こういったことがハードルとなって、推論を利用したアプリケーションの活用が場所・価格・電力など様々な観点から遅れがちになっていました。

https://www.intel.co.jp/content/www/jp/ja/internet-of-things/solution-briefs/openvino-toolkit-essential-brief.htmlIntel OpenVINO™はこうした課題を解決するためのプラットフォームです。

後ほど詳しくご説明いたしますが、機械学習モデル精度をある程度保持したまま単純化することにより、推論精度への影響を最小限にしながら処理負荷を劇的に削減することでCPU, GPU, FPGA, VPUなどIntelの様々なプラットフォーム上で推論処理をさせることが可能となっております。以下のような特徴があります。特徴

- 非常に多くの機械学習モデルがすぐに利用可能(Open Model ZOO)

- CPU, GPU, FPGA, VPUなど様々なプラットフォームでの動作が可能

- クラウドでの開発環境も提供(Intel DevCloud for the Edge)

- 活用支援のためのトレーニングプログラムが充実

Ciscoとの関連性

Ciscoと画像認識のような機械学習分野はあまり結びつきを持たないイメージをお持ちの方もいらっしゃるかと思います。

あまり馴染みのない製品もあるかとは思いますが、ネットワーク機器だけではなくて以下のような製品群にて機械学習が利用されております。

2020年12月9日、10日で行われたWebexOneというイベントでもWebexの新製品発表が行われましたが、会議のその中にもリアルタイム自動翻訳やコールセンターの音声認識及び機械学習による自動音声応答など様々な分野の製品で機械学習が使用されております。

https://www.webexoneevent.com/IntelとCiscoとは古くから様々な分野でパートナーシップを結んでいます。最近では2020年11月12日に発表されました「5Gショーケース」のエコパートナー様としてご支援いただいております。

https://www.cisco.com/c/m/ja_jp/5g-showcase.html#~customer-partnerIntel OpenVINO™を利用してみよう

それでは実際にIntel OpenVINO™を使用してみましょう。

OpenVINOを使用した開発環境は主にローカルコンピュータ上で行うものと上述のIntel DevCloud for the Edgeというクラウド上で行うものとがあります。

クラウド上につきましては最後の方で軽く触れますが、Webアプリケーションへの組み込みなど柔軟性の観点から本稿ではローカルコンピュータ上での開発環境を使用致します。

なお、OpenVINOはCPPも利用できますが、本稿では開発言語としてPythonを使用致しますので、Python環境の構築についても触れていきます。OpenVINO利用の手順は以下の通りとなります。

1. Intel Basic Accountの作成

2. OpenVINOのダウンロード

3. OpenVINOのインストール

4. Python実行環境構築

5. 任意のエディタでCodeを記述

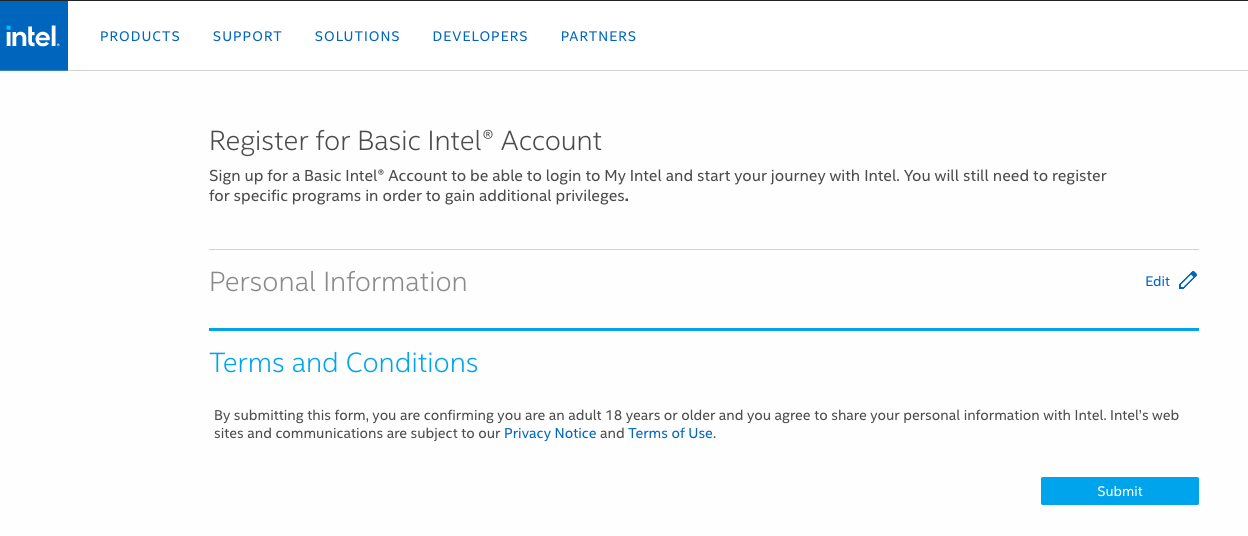

6. 実行及び結果の確認Intel Basic Accountを作成しよう

Register for Basic Intel® Accountにアクセスし、必要情報を入力します。入力する箇所が多いですが、めげないで入力しましょう。

入力したらNext Stepをクリックし、Privacy NoticeとTerms of Useに同意しSubmitをクリック。

OpenVINOのダウンロードをしてみよう

OpenVINO Downloadにアクセスし、ダウンロードする対象を選択します。以下のように選択します。

- Operating System: macOS

- Distribution: Web and Local Install

- Installer Type: Local

Register & Downloadを選択します。

Choose a Versionは2021.1を選択し、Full Packageを選択します。

m_openvino_toolkit_p_2021.1.110.dmgというファイルがダウンロードされます。

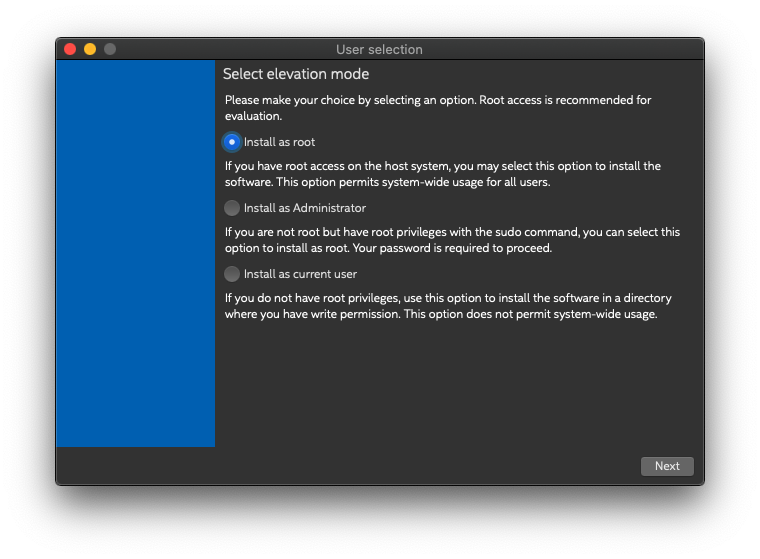

OpenVINO をインストールしてみよう

インストールの前提条件として以下の要件が必要になります。

一番下のApple Xcode IDEはOptionalです。

- CMake 3.10 or higher

- Python 3.6 - 3.7

- Apple Xcode* Command Line Tools (Optional) Apple Xcode* IDE (not required for OpenVINO, but useful for development)

インストール時にはCMakeが必要となりますので、homebrewでインストールしておきます。

$ brew install cmake$ brew install cmake Updating Homebrew... Warning: Treating cmake as a formula. For the cask, use homebrew/cask/cmake ==> Downloading https://homebrew.bintray.com/bottles/cmake-3.19.1.catalina.bottle.tar.gz Already downloaded: /Users/ktsutsum/Library/Caches/Homebrew/downloads/0908e631c8236f534e13e47da5070f8b651b7f59a5a97cd70899729d83baddd3--cmake-3.19.1.catalina.bottle.tar.gz ==> Pouring cmake-3.19.1.catalina.bottle.tar.gz ==> Caveats Emacs Lisp files have been installed to: /usr/local/share/emacs/site-lisp/cmake ==> Summary ? /usr/local/Cellar/cmake/3.19.1: 6,366 files, 63.9MB先ほどダウンロードしたm_openvino_toolkit_p_2021.1.110.dmgというファイルをダブルクリックして開きます。

以下のファイルをダブルクリックします。

ここではRootとしてインストールしています。

なぜか再度ロゴが表示されます。

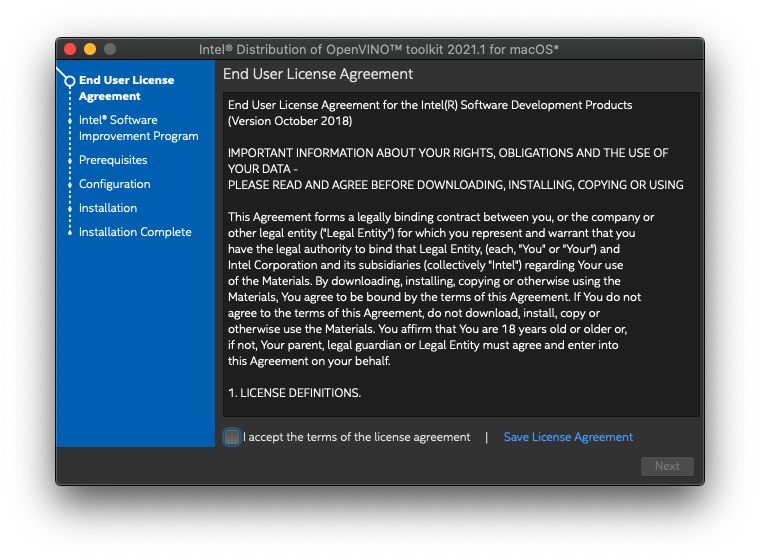

ライセンスに同意します。

情報提供を選択します。

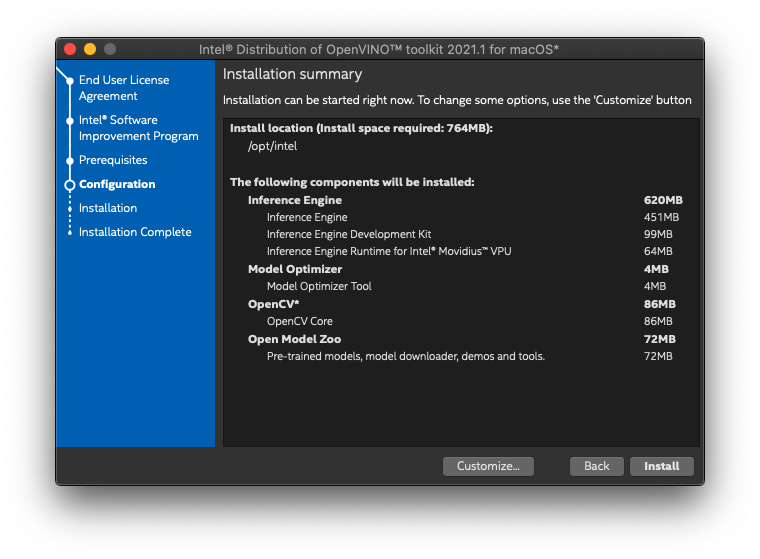

インストール内容を確認します。

インストールを待ちます。

最初のパートが終わったと表示されます。残りはFinishをクリックするとWebページに飛ばされます。

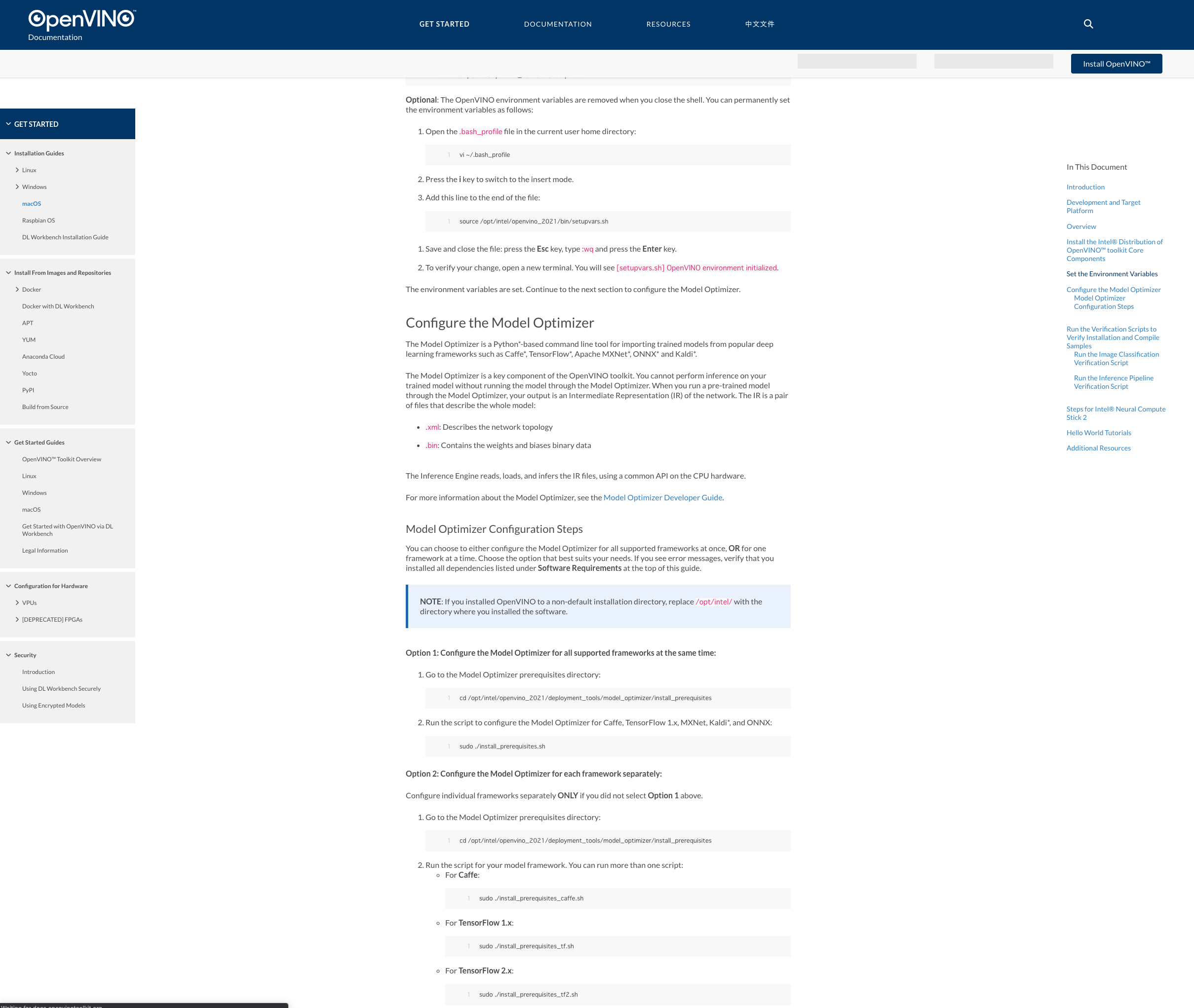

こちらのWebページに飛ばされます。

ここからは次のPython環境セットアップと一緒に進めていきます。Python実行環境を構築しよう

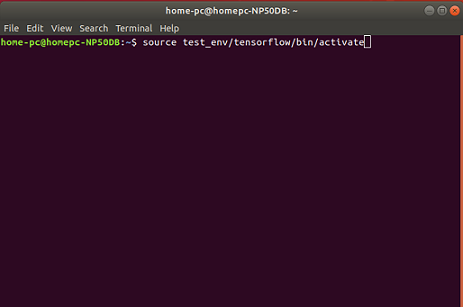

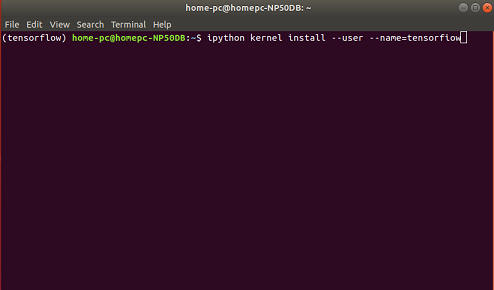

さて、次はPythonの実行環境を構築していきます。

1. pipenvのインストール

できるだけ環境を汚さないように仮想環境を作成します。仮想環境を作成する方法としてしてはAnacondaやpyenv,viratualenv等色々ありますが、今回は作成したCodeをWebアプリ化&コンテナ化するために必要パッケージをpackage-list.txtとして提示してくれるpipenvを利用します。

いつもどおりbrewでインストールしていきます。brew brewってなんやねん

macOS対応のパッケージ管理ソフトウェアです。Windowsでも使用できます。以下のリンクにある説明どおりにインストールすると今後も便利かと思います。

https://brew.sh/index_jaさて、気を取り直してpipenvをインストールしていきます。

$ brew install pipenv

出力結果は長いのでこんな感じです

$ brew install pipenv Updating Homebrew... ==> Downloading https://homebrew.bintray.com/bottles/openssl%401.1-1.1.1i.catalina.bottle.tar.gz ==> Downloading from https://d29vzk4ow07wi7.cloudfront.net/066b9f114617872e77fa3d4afee2337daabc2c181d7564fe60a5b26d89d69742?response-content-disposition=attachment%3Bfilename%3D%22o ######################################################################## 100.0% ==> Downloading https://homebrew.bintray.com/bottles/readline-8.1.catalina.bottle.tar.gz ==> Downloading from https://d29vzk4ow07wi7.cloudfront.net/fe4de019cf549376a7743dcb0c86db8a08ca2b6d0dd2f8cb796dd7cf973dc2e9?response-content-disposition=attachment%3Bfilename%3D%22r ######################################################################## 100.0% ==> Downloading https://homebrew.bintray.com/bottles/sqlite-3.34.0.catalina.bottle.tar.gz ==> Downloading from https://d29vzk4ow07wi7.cloudfront.net/7e04c1fcd0294ec7625e43eea05714d8bb4d15d24675c99484f1403fdcb438ec?response-content-disposition=attachment%3Bfilename%3D%22s ######################################################################## 100.0% ==> Downloading https://homebrew.bintray.com/bottles/python%403.9-3.9.1.catalina.bottle.tar.gz ==> Downloading from https://d29vzk4ow07wi7.cloudfront.net/2b9946108e230384c48fcb4fcc07febd31e3987a7b9e66ee952e2c4f153a5dee?response-content-disposition=attachment%3Bfilename%3D%22p ######################################################################## 100.0% ==> Downloading https://homebrew.bintray.com/bottles/pipenv-2020.11.15.catalina.bottle.tar.gz Already downloaded: /Users/ktsutsum/Library/Caches/Homebrew/downloads/eabcd8eb2a82ad7fbdd5f958a38256bd254a0d5fdf059e6217946c1a46fe950d--pipenv-2020.11.15.catalina.bottle.tar.gz ==> Installing dependencies for pipenv: openssl@1.1, readline, sqlite and python@3.9 ==> Installing pipenv dependency: openssl@1.1 ==> Pouring openssl@1.1-1.1.1i.catalina.bottle.tar.gz ==> Caveats A CA file has been bootstrapped using certificates from the system keychain. To add additional certificates, place .pem files in /usr/local/etc/openssl@1.1/certs and run /usr/local/opt/openssl@1.1/bin/c_rehash openssl@1.1 is keg-only, which means it was not symlinked into /usr/local, because macOS provides LibreSSL. If you need to have openssl@1.1 first in your PATH run: echo 'export PATH="/usr/local/opt/openssl@1.1/bin:$PATH"' >> /Users/ktsutsum/.bash_profile For compilers to find openssl@1.1 you may need to set: export LDFLAGS="-L/usr/local/opt/openssl@1.1/lib" export CPPFLAGS="-I/usr/local/opt/openssl@1.1/include" For pkg-config to find openssl@1.1 you may need to set: export PKG_CONFIG_PATH="/usr/local/opt/openssl@1.1/lib/pkgconfig" ==> Summary ? /usr/local/Cellar/openssl@1.1/1.1.1i: 8,067 files, 18.5MB ==> Installing pipenv dependency: readline ==> Pouring readline-8.1.catalina.bottle.tar.gz ==> Caveats readline is keg-only, which means it was not symlinked into /usr/local, because macOS provides BSD libedit. For compilers to find readline you may need to set: export LDFLAGS="-L/usr/local/opt/readline/lib" export CPPFLAGS="-I/usr/local/opt/readline/include" For pkg-config to find readline you may need to set: export PKG_CONFIG_PATH="/usr/local/opt/readline/lib/pkgconfig" ==> Summary ? /usr/local/Cellar/readline/8.1: 48 files, 1.6MB ==> Installing pipenv dependency: sqlite ==> Pouring sqlite-3.34.0.catalina.bottle.tar.gz ==> Caveats sqlite is keg-only, which means it was not symlinked into /usr/local, because macOS already provides this software and installing another version in parallel can cause all kinds of trouble. If you need to have sqlite first in your PATH run: echo 'export PATH="/usr/local/opt/sqlite/bin:$PATH"' >> /Users/ktsutsum/.bash_profile For compilers to find sqlite you may need to set: export LDFLAGS="-L/usr/local/opt/sqlite/lib" export CPPFLAGS="-I/usr/local/opt/sqlite/include" For pkg-config to find sqlite you may need to set: export PKG_CONFIG_PATH="/usr/local/opt/sqlite/lib/pkgconfig" ==> Summary ? /usr/local/Cellar/sqlite/3.34.0: 11 files, 4.1MB ==> Installing pipenv dependency: python@3.9 ==> Pouring python@3.9-3.9.1.catalina.bottle.tar.gz ==> /usr/local/Cellar/python@3.9/3.9.1/bin/python3 -s setup.py --no-user-cfg install --force --verbose --install-scripts=/usr/local/Cellar/python@3.9/3.9.1/bin --install-lib=/usr/lo ==> /usr/local/Cellar/python@3.9/3.9.1/bin/python3 -s setup.py --no-user-cfg install --force --verbose --install-scripts=/usr/local/Cellar/python@3.9/3.9.1/bin --install-lib=/usr/lo ==> /usr/local/Cellar/python@3.9/3.9.1/bin/python3 -s setup.py --no-user-cfg install --force --verbose --install-scripts=/usr/local/Cellar/python@3.9/3.9.1/bin --install-lib=/usr/lo ==> Caveats Python has been installed as /usr/local/bin/python3 Unversioned symlinks `python`, `python-config`, `pip` etc. pointing to `python3`, `python3-config`, `pip3` etc., respectively, have been installed into /usr/local/opt/python@3.9/libexec/bin You can install Python packages with pip3 install <package> They will install into the site-package directory /usr/local/lib/python3.9/site-packages See: https://docs.brew.sh/Homebrew-and-Python ==> Summary ? /usr/local/Cellar/python@3.9/3.9.1: 4,452 files, 70.9MB ==> Installing pipenv ==> Pouring pipenv-2020.11.15.catalina.bottle.tar.gz ==> Caveats Bash completion has been installed to: /usr/local/etc/bash_completion.d ==> Summary ? /usr/local/Cellar/pipenv/2020.11.15: 1,868 files, 25.4MB ==> Upgrading 2 dependents: poppler 20.11.0 -> 20.12.0, diff-pdf 0.4.1_7 -> 0.4.1_8 ==> Upgrading poppler 20.11.0 -> 20.12.0 ==> Downloading https://homebrew.bintray.com/bottles/qt-5.15.2.catalina.bottle.tar.gz ==> Downloading from https://d29vzk4ow07wi7.cloudfront.net/51ab78a99ff3498a236d15d9bed92962ddd2499c4020356469f7ab1090cf6825?response-content-disposition=attachment%3Bfilename%3D%22q ######################################################################## 100.0% ==> Downloading https://homebrew.bintray.com/bottles/poppler-20.12.0.catalina.bottle.tar.gz ==> Downloading from https://d29vzk4ow07wi7.cloudfront.net/d89f6b867a6f012f44886b157f35f33179c583af93ace39329e7b62d2482eb31?response-content-disposition=attachment%3Bfilename%3D%22p ######################################################################## 100.0% ==> Installing dependencies for poppler: qt ==> Installing poppler dependency: qt ==> Pouring qt-5.15.2.catalina.bottle.tar.gz ==> Caveats We agreed to the Qt open source license for you. If this is unacceptable you should uninstall. qt is keg-only, which means it was not symlinked into /usr/local, because Qt 5 has CMake issues when linked. If you need to have qt first in your PATH run: echo 'export PATH="/usr/local/opt/qt/bin:$PATH"' >> /Users/ktsutsum/.bash_profile For compilers to find qt you may need to set: export LDFLAGS="-L/usr/local/opt/qt/lib" export CPPFLAGS="-I/usr/local/opt/qt/include" For pkg-config to find qt you may need to set: export PKG_CONFIG_PATH="/usr/local/opt/qt/lib/pkgconfig" ==> Summary ? /usr/local/Cellar/qt/5.15.2: 10,688 files, 367.9MB ==> Installing poppler ==> Pouring poppler-20.12.0.catalina.bottle.tar.gz ? /usr/local/Cellar/poppler/20.12.0: 474 files, 26.8MB Removing: /usr/local/Cellar/poppler/20.11.0... (476 files, 26.7MB) Removing: /Users/ktsutsum/Library/Caches/Homebrew/poppler--20.11.0.catalina.bottle.tar.gz... (8.1MB) ==> Upgrading diff-pdf 0.4.1_7 -> 0.4.1_8 ==> Downloading https://homebrew.bintray.com/bottles/diff-pdf-0.4.1_8.catalina.bottle.tar.gz #=#=-# # curl: (22) The requested URL returned error: 404 Not Found Error: Failed to download resource "diff-pdf" Download failed: https://homebrew.bintray.com/bottles/diff-pdf-0.4.1_8.catalina.bottle.tar.gz Warning: Bottle installation failed: building from source. ==> Downloading https://homebrew.bintray.com/bottles/automake-1.16.3.catalina.bottle.tar.gz ==> Downloading from https://d29vzk4ow07wi7.cloudfront.net/25fe47e5fb1af734423e1e73f0dc53637e89d825ef8d8199add239352b5b974e?response-content-disposition=attachment%3Bfilename%3D%22a ######################################################################## 100.0% ==> Downloading https://github.com/vslavik/diff-pdf/releases/download/v0.4.1/diff-pdf-0.4.1.tar.gz ==> Downloading from https://github-production-release-asset-2e65be.s3.amazonaws.com/353360/b335c080-3951-11ea-98d4-aa100bba0fcf?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=AK ######################################################################## 100.0% Warning: A newer Command Line Tools release is available. Update them from Software Update in System Preferences or run: softwareupdate --all --install --force If that doesn't show you an update run: sudo rm -rf /Library/Developer/CommandLineTools sudo xcode-select --install Alternatively, manually download them from: https://developer.apple.com/download/more/. ==> Installing dependencies for diff-pdf: automake ==> Installing diff-pdf dependency: automake ==> Pouring automake-1.16.3.catalina.bottle.tar.gz ? /usr/local/Cellar/automake/1.16.3: 131 files, 3.4MB ==> Installing diff-pdf ==> ./configure --prefix=/usr/local/Cellar/diff-pdf/0.4.1_8 Last 15 lines from /Users/ktsutsum/Library/Logs/Homebrew/diff-pdf/01.configure: checking for style of include used by make... GNU checking dependency style of clang++... none checking for pkg-config... /usr/local/Homebrew/Library/Homebrew/shims/mac/super/pkg-config checking pkg-config is at least version 0.9.0... yes checking for POPPLER... no configure: error: Package requirements (poppler-cairo >= 0.10 poppler-glib >= 0.10 cairo-pdf) were not met: No package 'poppler-cairo' found Consider adjusting the PKG_CONFIG_PATH environment variable if you installed software in a non-standard prefix. Alternatively, you may set the environment variables POPPLER_CFLAGS and POPPLER_LIBS to avoid the need to call pkg-config. See the pkg-config man page for more details. READ THIS: https://docs.brew.sh/Troubleshooting These open issues may also help: diff-pdf failing to build on macOS 10.15.7 https://github.com/Homebrew/homebrew-core/issues/66385 Error: A newer Command Line Tools release is available. Update them from Software Update in System Preferences or run: softwareupdate --all --install --force If that doesn't show you an update run: sudo rm -rf /Library/Developer/CommandLineTools sudo xcode-select --install Alternatively, manually download them from: https://developer.apple.com/download/more/. ==> Checking for dependents of upgraded formulae... ==> No broken dependents to reinstall! ==> Caveats ==> openssl@1.1 A CA file has been bootstrapped using certificates from the system keychain. To add additional certificates, place .pem files in /usr/local/etc/openssl@1.1/certs and run /usr/local/opt/openssl@1.1/bin/c_rehash openssl@1.1 is keg-only, which means it was not symlinked into /usr/local, because macOS provides LibreSSL. If you need to have openssl@1.1 first in your PATH run: echo 'export PATH="/usr/local/opt/openssl@1.1/bin:$PATH"' >> /Users/ktsutsum/.bash_profile For compilers to find openssl@1.1 you may need to set: export LDFLAGS="-L/usr/local/opt/openssl@1.1/lib" export CPPFLAGS="-I/usr/local/opt/openssl@1.1/include" For pkg-config to find openssl@1.1 you may need to set: export PKG_CONFIG_PATH="/usr/local/opt/openssl@1.1/lib/pkgconfig" ==> readline readline is keg-only, which means it was not symlinked into /usr/local, because macOS provides BSD libedit. For compilers to find readline you may need to set: export LDFLAGS="-L/usr/local/opt/readline/lib" export CPPFLAGS="-I/usr/local/opt/readline/include" For pkg-config to find readline you may need to set: export PKG_CONFIG_PATH="/usr/local/opt/readline/lib/pkgconfig" ==> sqlite sqlite is keg-only, which means it was not symlinked into /usr/local, because macOS already provides this software and installing another version in parallel can cause all kinds of trouble. If you need to have sqlite first in your PATH run: echo 'export PATH="/usr/local/opt/sqlite/bin:$PATH"' >> /Users/ktsutsum/.bash_profile For compilers to find sqlite you may need to set: export LDFLAGS="-L/usr/local/opt/sqlite/lib" export CPPFLAGS="-I/usr/local/opt/sqlite/include" For pkg-config to find sqlite you may need to set: export PKG_CONFIG_PATH="/usr/local/opt/sqlite/lib/pkgconfig" ==> python@3.9 Python has been installed as /usr/local/bin/python3 Unversioned symlinks `python`, `python-config`, `pip` etc. pointing to `python3`, `python3-config`, `pip3` etc., respectively, have been installed into /usr/local/opt/python@3.9/libexec/bin You can install Python packages with pip3 install <package> They will install into the site-package directory /usr/local/lib/python3.9/site-packages See: https://docs.brew.sh/Homebrew-and-Python ==> pipenv Bash completion has been installed to: /usr/local/etc/bash_completion.d ==> qt We agreed to the Qt open source license for you. If this is unacceptable you should uninstall. qt is keg-only, which means it was not symlinked into /usr/local, because Qt 5 has CMake issues when linked. If you need to have qt first in your PATH run: echo 'export PATH="/usr/local/opt/qt/bin:$PATH"' >> /Users/ktsutsum/.bash_profile For compilers to find qt you may need to set: export LDFLAGS="-L/usr/local/opt/qt/lib" export CPPFLAGS="-I/usr/local/opt/qt/include" For pkg-config to find qt you may need to set: export PKG_CONFIG_PATH="/usr/local/opt/qt/lib/pkgconfig"

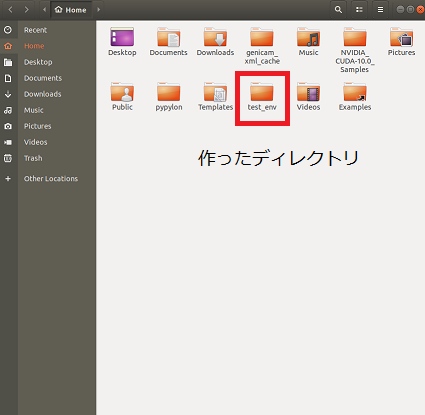

2. 仮想環境の準備

作業フォルダに移動したら、pipenvでpythonの仮想環境を作成していきます。

以下のような書式でpythonのバージョンを指定します。OpenVINOはpython3.7までの対応のため今回はpython3.7にて環境を作成していきます。$ pipenv --python 3.7$ pipenv --python 3.7 Virtualenv already exists! Removing existing virtualenv... Warning: the environment variable LANG is not set! We recommend setting this in ~/.profile (or equivalent) for proper expected behavior. Creating a virtualenv for this project... Pipfile: /Users/ktsutsum/openvino/demos/Pipfile Using /usr/bin/python3 (3.7.3) to create virtualenv... ⠇ Creating virtual environment...created virtual environment CPython3.7.3.final.0-64 in 458ms creator CPython3macOsFramework(dest=/Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME, clear=False, global=False) seeder FromAppData(download=False, pip=bundle, setuptools=bundle, wheel=bundle, via=copy, app_data_dir=/Users/ktsutsum/Library/Application Support/virtualenv) added seed packages: pip==20.2.4, setuptools==50.3.2, wheel==0.35.1 activators BashActivator,CShellActivator,FishActivator,PowerShellActivator,PythonActivator,XonshActivator ✔ Successfully created virtual environment! Virtualenv location: /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME3. 仮想環境を使用してOpenVINOインストールの続き

仮想環境利用してOpenVINOの残りのセットアップを進めていきましょう。

まず先ほど作成した仮想環境のShellに入ります。$ pipenv shellhttps://docs.openvinotoolkit.org/latest/openvino_docs_install_guides_installing_openvino_macos.html

OpenVINOインストール続きはこちらのページをご参照いただきながら進め行ければと思います。環境変数をSourceします。

(demos) bash-3.2$ source /opt/intel/openvino_2021/bin/setupvars.sh [setupvars.sh] OpenVINO environment initializedModel Optimizerのインストールに必要なパッケージを事前にインストールします。

(demos) bash-3.2$ cd /opt/intel/openvino_2021/deployment_tools/model_optimizer/install_prerequisites (demos) bash-3.2$ sudo ./install_prerequisites.sh WARNING: The directory '/Users/ktsutsum/Library/Caches/pip' or its parent directory is not owned or is not writable by the current user. The cache has been disabled. Check the permissions and owner of that directory. If executing pip with sudo, you may want sudo's -H flag. Ignoring tensorflow: markers 'python_version >= "3.8"' don't match your environment Requirement already satisfied: tensorflow<2.0,>=1.15.2 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from -r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (1.15.4) Requirement already satisfied: mxnet<=1.5.1,>=1.0.0 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from -r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 3)) (1.5.1) Requirement already satisfied: networkx>=1.11 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from -r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 4)) (2.5) Requirement already satisfied: numpy>=1.13.0 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from -r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 5)) (1.19.4) Requirement already satisfied: protobuf>=3.6.1 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from -r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 6)) (3.14.0) Requirement already satisfied: onnx>=1.1.2 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from -r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 7)) (1.8.0) Requirement already satisfied: test-generator==0.1.1 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from -r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 8)) (0.1.1) Requirement already satisfied: defusedxml>=0.5.0 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from -r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 9)) (0.6.0) Requirement already satisfied: six in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from test-generator==0.1.1->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 8)) (1.15.0) Requirement already satisfied: requests<3,>=2.20.0 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from mxnet<=1.5.1,>=1.0.0->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 3)) (2.25.0) Requirement already satisfied: graphviz<0.9.0,>=0.8.1 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from mxnet<=1.5.1,>=1.0.0->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 3)) (0.8.4) Requirement already satisfied: decorator>=4.3.0 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from networkx>=1.11->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 4)) (4.4.2) Requirement already satisfied: typing-extensions>=3.6.2.1 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from onnx>=1.1.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 7)) (3.7.4.3) Requirement already satisfied: astor>=0.6.0 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (0.8.1) Requirement already satisfied: wrapt>=1.11.1 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (1.12.1) Requirement already satisfied: tensorflow-estimator==1.15.1 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (1.15.1) Requirement already satisfied: termcolor>=1.1.0 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (1.1.0) Requirement already satisfied: google-pasta>=0.1.6 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (0.2.0) Requirement already satisfied: keras-preprocessing>=1.0.5 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (1.1.2) Requirement already satisfied: tensorboard<1.16.0,>=1.15.0 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (1.15.0) Requirement already satisfied: grpcio>=1.8.6 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (1.34.0) Requirement already satisfied: absl-py>=0.7.0 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (0.11.0) Requirement already satisfied: gast==0.2.2 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (0.2.2) Requirement already satisfied: opt-einsum>=2.3.2 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (3.3.0) Requirement already satisfied: wheel>=0.26 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (0.35.1) Requirement already satisfied: keras-applications>=1.0.8 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (1.0.8) Collecting numpy>=1.13.0 Downloading numpy-1.18.5-cp37-cp37m-macosx_10_9_x86_64.whl (15.1 MB) |████████████████████████████████| 15.1 MB 2.3 MB/s Requirement already satisfied: h5py in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from keras-applications>=1.0.8->tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (3.1.0) Requirement already satisfied: idna<3,>=2.5 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from requests<3,>=2.20.0->mxnet<=1.5.1,>=1.0.0->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 3)) (2.10) Requirement already satisfied: urllib3<1.27,>=1.21.1 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from requests<3,>=2.20.0->mxnet<=1.5.1,>=1.0.0->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 3)) (1.26.2) Requirement already satisfied: certifi>=2017.4.17 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from requests<3,>=2.20.0->mxnet<=1.5.1,>=1.0.0->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 3)) (2020.12.5) Requirement already satisfied: chardet<4,>=3.0.2 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from requests<3,>=2.20.0->mxnet<=1.5.1,>=1.0.0->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 3)) (3.0.4) Requirement already satisfied: markdown>=2.6.8 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorboard<1.16.0,>=1.15.0->tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (3.3.3) Requirement already satisfied: setuptools>=41.0.0 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorboard<1.16.0,>=1.15.0->tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (50.3.2) Requirement already satisfied: werkzeug>=0.11.15 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from tensorboard<1.16.0,>=1.15.0->tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (1.0.1) Requirement already satisfied: importlib-metadata in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from markdown>=2.6.8->tensorboard<1.16.0,>=1.15.0->tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (3.3.0) Requirement already satisfied: cached-property in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from h5py->keras-applications>=1.0.8->tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (1.5.2) Requirement already satisfied: zipp>=0.5 in /Users/ktsutsum/.local/share/virtualenvs/demos-UH30-bME/lib/python3.7/site-packages (from importlib-metadata->markdown>=2.6.8->tensorboard<1.16.0,>=1.15.0->tensorflow<2.0,>=1.15.2->-r /opt/intel/openvino_2021.1.110/deployment_tools/model_optimizer/install_prerequisites/../requirements.txt (line 1)) (3.4.0) Installing collected packages: numpy Attempting uninstall: numpy Found existing installation: numpy 1.19.4 Uninstalling numpy-1.19.4: Successfully uninstalled numpy-1.19.4 Successfully installed numpy-1.18.5 [WARNING] All Model Optimizer dependencies are installed globally. [WARNING] If you want to keep Model Optimizer in separate sandbox [WARNING] run install_prerequisites.sh venv {caffe|tf|tf2|mxnet|kaldi|onnx}こちらで仮想環境の構築とOpenVINOインストールは完了です。

実際に Code を書いてみよう

それでは実際にCodeを書いていきましょう。

今回使用するモジュールは以下のとおりです。はじめにこれらをImportします。

エディタはお好きなものを利用して良いと思います。私は普通にvimを使っています。

名称 概要 openvino OpenVINO本体 Numpy Pythonの数値計算を行うライブラリ Sys Python のインタプリタや実行環境に関連 # 必要なモジュール、ライブラリをインポート import cv2 import numpy as np import sys sys.path.append from openvino.inference_engine import IENetwork, IECoreなにやらIE NetworkとIE Coreというものが出てきましたね。

IEはInference Engineの略です。IENetworkというモジュールは今回の2021.1バージョンからIECoreに統合されましたので使用しないのですが、

2020バージョンを利用する場合の後方互換性としてCode上残してあります。Inference Engineというのはモデルをモデルオプティマイザーによって最適化したものです。最適化とは何をしているかというと精度をほぼ失うことなくモデルの重みの最良歯科を行うことにより処理負荷を劇的に下げるような変換です。

ここで、今回使用するモデルのご紹介をいたします。

モデル名称 emotions_recognition_retail_0003 Input face orientation Frontal Rotation in-plane 2±15˚ Rotation out-of-plane Yaw: ±15˚ / Pitch: ±15˚ Min object width 64 pixels GFlops 0.126 MParams 2.483 Source framework Caffe

モデル名称 face-detection-retail-0004 AP (WIDER) 83.00% GFlops 1.067 MParams 0.588 Source framework Caffe 上記モデルを読み込みます。

# Face Detection Model net = ie.read_network(model='intel/face-detection-retail-0004/FP16/face-detection-retail-0004.xml', weights='intel/face-detection-retail-0004/FP16/face-detection-retail-0004.bin') exec_net = ie.load_network(network=net, device_name="CPU", num_requests=0) # Emotion Detection Model net_emotion = ie.read_network(model='intel/emotions-recognition-retail-0003/FP16/emotions-recognition-retail-0003.xml', weights='intel/emotions-recognition-retail-0003/FP16/emotions-recognition-retail-0003.bin') exec_net_emotion = ie.load_network(network=net_emotion, device_name="CPU", num_requests=0)ここで、モデルへのパス指定をしていますが、まだモデルは手元にないと思いますのでモデルをダウンローダーを使って手に入れましょう。

(face-detection) bash-3.2$ python3 /opt/intel/openvino_2021/deployment_tools/tools/model_downloader/downloader.py --name face-detection-retail-0004 Traceback (most recent call last): File "/opt/intel/openvino_2021/deployment_tools/tools/model_downloader/downloader.py", line 25, in <module> import requests ModuleNotFoundError: No module named 'requests'requests moduleをインストールします

(face-detection) bash-3.2$ pipenv install requests Installing requests... Adding requests to Pipfile's [packages]... ✔ Installation Succeeded Pipfile.lock (9be4f8) out of date, updating to (444a6d)... Locking [dev-packages] dependencies... Locking [packages] dependencies... Building requirements... Resolving dependencies... ✔ Success! Updated Pipfile.lock (444a6d)! Installing dependencies from Pipfile.lock (444a6d)... ? ▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉ 0/0 — 00:00:00もう一度チャレンジ

(face-detection) bash-3.2$ python3 /opt/intel/openvino_2021/deployment_tools/tools/model_downloader/downloader.py --name face-detection-retail-0004 Traceback (most recent call last): File "/opt/intel/openvino_2021/deployment_tools/tools/model_downloader/downloader.py", line 37, in <module> import common File "/opt/intel/openvino_2021.1.110/deployment_tools/open_model_zoo/tools/downloader/common.py", line 33, in <module> import yaml ModuleNotFoundError: No module named 'yaml'pyyaml moduleをインストールします

(face-detection) bash-3.2$ pipenv install pyyaml Installing pyyaml... Adding pyyaml to Pipfile's [packages]... ✔ Installation Succeeded Pipfile.lock (444a6d) out of date, updating to (c30804)... Locking [dev-packages] dependencies... Locking [packages] dependencies... Building requirements... Resolving dependencies... ✔ Success! Updated Pipfile.lock (c30804)! Installing dependencies from Pipfile.lock (c30804)... ? ▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉▉ 0/0 — 00:00:00今度こそ

(face-detection) bash-3.2$ python3 /opt/intel/openvino_2021/deployment_tools/tools/model_downloader/downloader.py --name face-detection-retail-0004 ################|| Downloading face-detection-retail-0004 ||################ ========== Downloading /Users/ktsutsum/openvino/demos/face-detection/intel/face-detection-retail-0004/FP32/face-detection-retail-0004.xml ... 100%, 98 KB, 166814 KB/s, 0 seconds passed ========== Downloading /Users/ktsutsum/openvino/demos/face-detection/intel/face-detection-retail-0004/FP32/face-detection-retail-0004.bin ... 100%, 2297 KB, 12116 KB/s, 0 seconds passed ========== Downloading /Users/ktsutsum/openvino/demos/face-detection/intel/face-detection-retail-0004/FP16/face-detection-retail-0004.xml ... 100%, 97 KB, 210379 KB/s, 0 seconds passed ========== Downloading /Users/ktsutsum/openvino/demos/face-detection/intel/face-detection-retail-0004/FP16/face-detection-retail-0004.bin ... 100%, 1148 KB, 20286 KB/s, 0 seconds passed ========== Downloading /Users/ktsutsum/openvino/demos/face-detection/intel/face-detection-retail-0004/FP16-INT8/face-detection-retail-0004.xml ... 100%, 240 KB, 257964 KB/s, 0 seconds passed ========== Downloading /Users/ktsutsum/openvino/demos/face-detection/intel/face-detection-retail-0004/FP16-INT8/face-detection-retail-0004.bin ... 100%, 586 KB, 13932 KB/s, 0 seconds passedこれでモデルをダウンローダーが完了です。

これと同じことをemotions-recognition-retail-0003についても実施します。

ここでは割愛しますが、上記のコマンドのモデル名だけを変更して実施してみてください。続いて解析本体部分となります。非常に短いCodeです。

本稿ではOpenVINOについて取り上げておりますので、その他の説明については簡易にとどめておきます。cap = cv2.VideoCapture(1) while True: ret, frame = cap.read() if ret == False: continue img = cv2.resize(frame, (300, 300)) img = img.transpose((2, 0, 1)) img = np.expand_dims(img, axis=0) out = exec_net.infer(inputs={'data': img}) out = out['detection_out'] out = np.squeeze(out) for detection in out: confidence = float(detection[2]) xmin = int(detection[3] * frame.shape[1]) ymin = int(detection[4] * frame.shape[0]) xmax = int(detection[5] * frame.shape[1]) ymax = int(detection[6] * frame.shape[0]) if confidence > 0.5: cv2.rectangle(frame, (xmin, ymin), (xmax, ymax), color=(xmin, ymin, 0), thickness=3) frame_face = frame[ymin:ymax, xmin:xmax] img = cv2.resize(frame_face, (64, 64)) img = img.transpose((2, 0, 1)) img = np.expand_dims(img, axis=0) out = exec_net_emotion.infer(inputs={'data': img}) out = out['prob_emotion'] out = np.squeeze(out) index_max = np.argmax(out) list_emotion = ['neutral', 'happy', 'sad', 'surprise', 'anger'] cv2.putText(frame, list_emotion[index_max], (xmin, ymin - 10), cv2.FONT_HERSHEY_SIMPLEX, 1, (xmin, ymin, 0), 2) cv2.imshow('image', frame) key = cv2.waitKey(1) if key != -1: break cap.release() cv2.destoryAllWindows()まず以下の部分ですが、opencvを使用して内蔵カメラからの画像を取り込んでいます。

cv2.VideoCapture(1)の数字部分(1)はお手もと環境により異なります。通常は(0)の場合が多いです。

retにはtrue or false, frameには画像が配列で取り込まれます。画像がある場合ret = trueとなります。cap = cv2.VideoCapture(1) while True: ret, frame = cap.read() if ret == False: continue次にこちら。

img = cv2.resize(frame, (300, 300)) img = img.transpose((2, 0, 1)) img = np.expand_dims(img, axis=0)

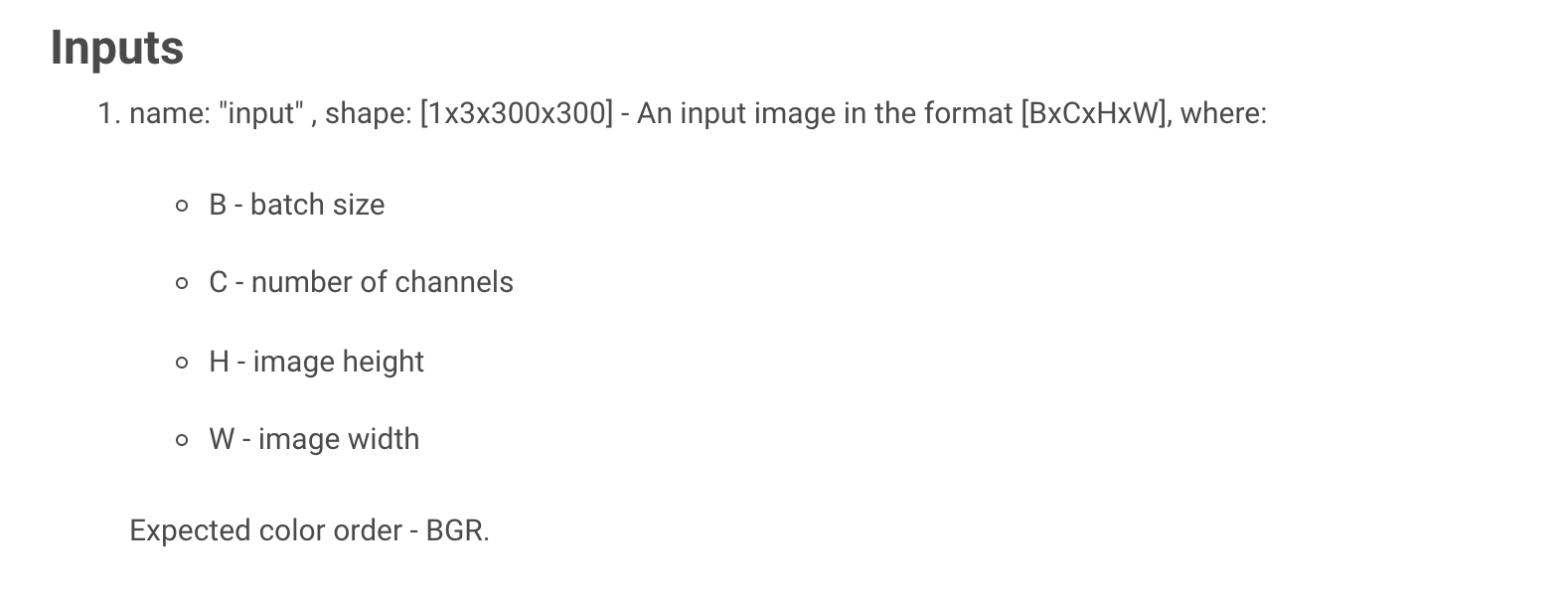

- resizeにより入力に必要なサイズ(300, 300)へ変換しています。

- transposeにより(h, w, c)から(c, h, w)への変換をしています。

- h : height(高さ)

- w : width(幅)

- c : channel(チャネル:色情報)

OpenCVは(h, w, c)の順番で画像を取り込みますがこのモデルでは以下のように(c, w, h)の順番で渡してやる必要があリます。

- expand_dimsで次元の追加 上記のように入力が期待するものは[1x3x300x300]です。ただここまでの変換だと[3x300x300]と1次元足りません。 expand_dims(axis = 0)と指定することにより次元を追加し[1x3x300x300]とすることが可能です。

次のセクションに行きましょう。

out = exec_net.infer(inputs={'data': img})imgに対して事前に定義したexec_netのinferメソッドを利用し推論を実施します。

out = out['detection_out']ではoutのデータはどのようなものでしょうか?実際にprintしてみると以下のようなarrayで返されてきます。

detection_outという名前だということがわかりますので、out = out['detection_out']としています。{'detection_out': array([[[[0. , 1. , 1. , ..., 0.1926786 , 0.77813023, 0.92338395], [0. , 1. , 0.02098523, ..., 0.9338631 , 0.99440974, 1.0033596 ], [0. , 1. , 0.01355048, ..., 0.01246494, 0.70711267, 0.40890545], ..., [0. , 0. , 0. , ..., 0. , 0. , 0. ], [0. , 0. , 0. , ..., 0. , 0. , 0. ], [0. , 0. , 0. , ..., 0. , 0. , 0. ]]]], dtype=float32)}ここで、outputのshapeを見てみましょう。[1, 1, N, 7]だということがわかりますが、はじめの[1, 1]は実際の処理には不要です。

そういった場合は、1次元の要素を削除できるsqueezeメソッドを利用します。

out = np.squeeze(out)さて、上記の[N, 7]という行列の"7"の中身を見てみましょう。以下のようになっています。

- image_id - ID of the image in the batch : 1個

- label - predicted class ID : 1個

- conf - confidence for the predicted class : 1個

- (x_min, y_min) - coordinates of the top left bounding box corner : 2個

- (x_max, y_max) - coordinates of the bottom right bounding box corner. : 2個

for detection in out: confidence = float(detection[2]) xmin = int(detection[3] * frame.shape[1]) ymin = int(detection[4] * frame.shape[0]) xmax = int(detection[5] * frame.shape[1]) ymax = int(detection[6] * frame.shape[0])Confidenceというここが顔だよという確信度をconfidenceに入れています。

下の部分では顔部分のx_min(x座標の最小値)、y_min(y座標の最小値)、x_max(x座標の最大値)、y_max(y座標の最大値)を求めています。

x_min, y_min, x_max, y_maxは0-1までの少数で与えられるため、実際のframeサイズを乗算して実際の一を割り出しています。ちなみに、NというのはBounding Boxの個数です。この1個めの座標、2個めの座標というような感じです。

if confidence > 0.5: cv2.rectangle(frame, (xmin, ymin), (xmax, ymax), color=(xmin, ymin, 0), thickness=3) frame_face = frame[ymin:ymax, xmin:xmax]ここからは多少まとめて説明していきます。

Confidenceが0.5以上のものを選んで顔部分のBounding Boxの個数を減らしていきます。

cv2.rectangleメソッドを利用し四角形を書いていきます。frame_faceには顔部分の領域だけをndarrayとして切り出します。スライスを使います。

ここから先はemotions-recognition-retail-0003モデルを使用し、上記で切り出した顔領域に対して感情認識を行っていきます。img = cv2.resize(frame_face, (64, 64)) img = img.transpose((2, 0, 1)) img = np.expand_dims(img, axis=0)顔領域認識モデルと同じ処理を行っていきます。

感情認識モデルは上記の通りinputの画像が64 x 64を期待するモデルです。

- resizeにより入力に必要なサイズ(64, 64)へ変換しています。

- transposeにより(h, w, c)から(c, h, w)への変換をしています。

out = exec_net_emotion.infer(inputs={'data': img}) out = out['prob_emotion'] out = np.squeeze(out)outにはexec_net_emotion.inferにより感情認識した結果が入ります。

どのような形式で結果が入るかというと上記にある通り、shape[1, 5, 1, 1]となり、2番めの要素として以下の5種類の感情に分類された結果が入ります。

- neutral

- happy

- sad

- surprise

- anger

ここでもoutがどういう結果になるか見てみましょう。

{'prob_emotion': array([[[[8.9757685e-03]], [[9.8825932e-01]], [[1.2316966e-03]], [[7.2518183e-04]], [[8.0798665e-04]]]], dtype=float32)}prob_emotionという名前の配列になっているということがわかります。

ということですので、outにはout['prob_emotion']を代入し、squeezeにより余分な要素を削除してきます。

上記の例ではhappyが確率が高いということがわかりますね。index_max = np.argmax(out) list_emotion = ['neutral', 'happy', 'sad', 'surprise', 'anger']人の目で判断してもよいのですが、argmaxを使うと最大値がわかります。一番確率の高いものがわかるわけですね。

list_emotionというリストを作り、モデルの出力と同じ順番で感情の分類をリストに入れていきます。

argmaxによりリストのどの要素が最大値となるかがわかりますので、この場合ですとhappyが選択されることになります。cv2.putText(frame, list_emotion[index_max], (xmin, ymin - 10), cv2.FONT_HERSHEY_SIMPLEX, 1, (xmin, ymin, 0), 2)フォントを指定し、putTextメソッドを利用しテキストを画面内に書いていきます。場所は顔領域の上側10pixelとします。1, (xmin, ymin, 0), 2はそれぞれフォントの大きさ、色、フォントの太さを表しています。ここでは複数の人物が画面内にいたときにすべて同じ色にならないように座標により色を変えています。実際にコードで試してみてください。

cv2.imshow('image', frame)imshowにより実際に画面に描画します。

key = cv2.waitKey(1) if key != -1: break cap.release() cv2.destoryAllWindows()waitKeyによりキー入力を待ち、何らかのキーが入力されたら画面を閉じます。

最後にコード全体を載せておきます。

import cv2 import numpy as np import sys sys.path.append from openvino.inference_engine import IENetwork, IECore ie = IECore() # Face Detection Model net = ie.read_network(model='intel/face-detection-retail-0004/FP16/face-detection-retail-0004.xml', weights='intel/face-detection-retail-0004/FP16/face-detection-retail-0004.bin') exec_net = ie.load_network(network=net, device_name="CPU", num_requests=0) # Emotion Detection Model net_emotion = ie.read_network(model='intel/emotions-recognition-retail-0003/FP16/emotions-recognition-retail-0003.xml', weights='intel/emotions-recognition-retail-0003/FP16/emotions-recognition-retail-0003.bin') exec_net_emotion = ie.load_network(network=net_emotion, device_name="CPU", num_requests=0) cap = cv2.VideoCapture(3) while True: ret, frame = cap.read() if ret == False: continue img = cv2.resize(frame, (300, 300)) img = img.transpose((2, 0, 1)) img = np.expand_dims(img, axis=0) out = exec_net.infer(inputs={'data': img}) out = out['detection_out'] out = np.squeeze(out) for detection in out: confidence = float(detection[2]) xmin = int(detection[3] * frame.shape[1]) ymin = int(detection[4] * frame.shape[0]) xmax = int(detection[5] * frame.shape[1]) ymax = int(detection[6] * frame.shape[0]) if confidence > 0.5: cv2.rectangle(frame, (xmin, ymin), (xmax, ymax), color=(xmin, ymin, 0), thickness=3) frame_face = frame[ymin:ymax, xmin:xmax] img = cv2.resize(frame_face, (64, 64)) img = img.transpose((2, 0, 1)) img = np.expand_dims(img, axis=0) out = exec_net_emotion.infer(inputs={'data': img}) out = out['prob_emotion'] out = np.squeeze(out) index_max = np.argmax(out) list_emotion = ['neutral', 'happy', 'sad', 'surprise', 'anger'] cv2.putText(frame, list_emotion[index_max], (xmin, ymin - 10), cv2.FONT_HERSHEY_SIMPLEX, 1, (xmin, ymin, 0), 2) cv2.imshow('image', frame) key = cv2.waitKey(1) if key != -1: break cap.release() cv2.destoryAllWindows()おまけ

本記事では主にローカルでの開発方法について記載していますが、クラウド上でOpenVINOのプロトタイプ開発も可能です。

Intel DevCloud for the EdgeというIntelが提供しているクラウド開発サービスがあります。

OpenVINOが予めインストールされたクラウド上の環境を利用でき、様々なIntelハードウェア(CPU/GPU/FPGA/VPU)上でアプリケーションを実行させることが可能です。

プロトタイプの実験を簡単に無料で実施することが可能です。

大きな特徴として、Jupyter-Notebookを利用した開発が可能ですが、簡単に①〜⑥について説明します。①②:コード作成

* Jupyter-NotebookによりOpenVINOを使ったコードを記述

* OpenModelZooやModel Optimizerを利用してモデルを準備

* もし必要であればStorageServerから動画やイメージを推論させることも可能③④:ジョブを実行

* CPU,FPGA,GPU,VPU等様々なハードウェアから実行環境を選択

* アプリケーションをジョブに登録し、単体もしくは並列処理でのEdge Inferenceを実施⑤⑥:結果の出力

* Jupyter-Notebookで推論結果を画像やデータで表示実際に使用するには灯籠が必要ですが、以下のReferenceから登録が可能ですので興味を持たれた方はぜひお試しください。

来年はWebアプリ開発とそのパフォーマンス分析でも書こうかな。。Reference

- OpenVINO Resource

- OpenVINOを使う上でもモデルの情報など各種情報が取り揃えてあります。

- OpenVINO Documentation

- OpenVINOのインストール方法やpython以外の使用方法なども記載されております。

- Intel DevCloud for the Edge

- クラウドでのプロトタイプ開発が可能。予めIntelのリソースを組み込んだものを利用可能。

免責事項

本サイトおよび対応するコメントにおいて表明される意見は、投稿者本人の個人的意見であり、シスコの意見ではありません。本サイトの内容は、情報の提供のみを目的として掲載されており、シスコや他の関係者による推奨や表明を目的としたものではありません。各利用者は、本 Web サイトへの掲載により、投稿、リンクその他の方法でアップロードした全ての情報の内容に対して全責任を負い、本 Web サイトの利用に関するあらゆる責任からシスコを免責することに同意したものとします。

- 投稿日:2020-12-18T21:27:52+09:00

Python 正規表現を利用して任意の文字列群を抽出する / 名前付きグループを利用する

この記事はTakumi Akashiro ひとり Advent Calendar 2020の18日目の記事です。

始めに

みなさまは正規表現使ってますかー?!!!

私は最後に使ったのが1ヶ月前ぐらいですね。

必要なときが来るとバリバリ使います。そんな正規表現ですが、しっかり使うと任意の文字列群を良い感じに抽出できます。

TLDL

文字列群を取り出すときは名前付きグループを使おう!

>> text = "environ/house-food/apple-pie02.fbx" >> import re >> reg_text = r'(?P<main>(chara|environ))/(?P<sub>[^-/]*)-?(?P<sub_sub>[^/]*)/(?P<filling>[^-]*)-pie' >> match = re.search(reg_text, text) >> print(match.groupdict()) {'main': 'environ', 'sub': 'house', 'sub_sub': 'food', 'filling': 'apple'}正規表現の基本

まず正規表現の基本、適当にマッチをしていきます。

#! python3 import re def main(): # NOTE: どうでもいいですけど、正規表現のサンプルでアップルパイってよく見かけますよね。 text = "environ/house-food/apple-pie02.fbx" match_obj= re.search(r'pie', text) if match_obj: print("ヒットしたよ!") else: print("ヒットしないよ!") if __name__ == '__main__': main()ま、こんなもんです。超簡単ですね。

速度が求められて[^先頭一致が可能な場合は

re.matchを使ったり、置換したいときはre.sub使うぐらいできれば、

とりあえず正規表現を使うのには困らないですね。1

ではここで、

pieの前にある文字列appleを抽出するにはどうしましょう。

色々文字列を削ったりして取り出すと思います。でも取得対象が複数あるときは?例えば

environ、house、foodとappleを一気に取りたい場合は?こんなときに利用できるのがグループです。

ちょっと公式ドキュメントを読んでみましょう。正規表現のシンタックス

(中略)

(...)

丸括弧で囲まれた正規表現にマッチするとともに、グループの開始と終了を表します。

グループの中身は以下で述べるように、マッチが実行された後で回収したり、その文字列中で以降 \number 特殊シーケンスでマッチしたりできます。

リテラル '(' や ')' にマッチするには、( や ) を使うか、文字クラス中に囲みます: [(]、 [)] 。……どう使うんだか分からん……

というわけでサンプルを出してみます。グループを使ってみる

#! python3 import re def main(): text = "environ/house-food/apple-pie02.fbx" match_obj= re.search(r'([^/-]*)-?pie)', text) print(match_obj.groups()) if __name__ == '__main__': main()マッチオブジェクトに対して

match_obj.groups()することで、

グループ化した正規表現に引っかかった文字列のリストが取得できます。なので上記の

textからenviron、house、foodとappleを取り出したいと考えて,#! python3 import re def main(): text = "environ/house-food/apple-pie02.fbx" match = re.search(r'([^/-]*)/([^/-]*)-?([^/-]*)/([^/-]*)-?pie', text) if match: print(match.groups()) if __name__ == '__main__': main()とすれば……

まあまあ便利ですね!

listじゃなくてdictとしてほしいんだよなーとか、

正規表現じゃ()はよく使うから、必要な部分だけほしいんだよなーとかあると思います。そんなときにはコレ「名前付きグループ」です!

例のごとく、公式ドキュメントを読んでみます。

正規表現のシンタックス

(中略)

(?P<name>...)

通常の丸括弧に似ていますが、このグループがマッチした部分文字列はシンボリックグループ名 name でアクセスできます。

グループ名は有効な Python 識別子でなければならず、各グループ名は 1 個の正規表現内で一度だけ定義されていなければなりません。

シンボリックグループは、そのグループが名前付けされていなかったかのように番号付けされたグループでもあります。名前付きグループ を使ってみる

ま、とりあえず使えばわかるでしょうの精神で書きます。

#! python3 import re def main(): text = "environ/house-food/apple-pie02.fbx" match = re.search(r'(?P<main>[^/-]*)/(?P<sub>[^/-]*)-?(?P<sub_sub>[^/-]*)/(?P<filling>[^/-]*)-?pie', text) if match: print(match.groupdict()) if __name__ == '__main__': main()マッチオブジェクトに対して

match_obj.groupdict()することで、

名前がついたグループ化の辞書が取得できます。いい感じに取り出せてますね!

締め

なんも思いつかねえ……便利ですね!

追記: 速度を気にするような話であれば、forループ内で同じ正規表現を使う場合、forの外で

re.compileして再利用するとが若干早くなりますね。 ↩

- 投稿日:2020-12-18T20:42:52+09:00

たった1行から始めるPythonのAST(抽象構文木)入門

はじめに

この記事は2020年のRevCommアドベントカレンダー20日目の記事です。 19日目は@metal-presidentさんの「モバイルチームの成長とKMM導入に向けて」でした。

11月に株式会社RevCommに入社した@rhoboroです。

前職では主にGCP x Pythonで、現職では主にAWS x Pythonで日々業務を行なっています。

RevCommでは広島県の尾道からフルリモートワークで働いているので、そういった働き方にもし興味があればこちらの記事もご覧ください。それでは、本題に入ります。

PythonのAST(抽象構文木)とは?

この記事は、PythonのAST(抽象構文木、Astract Syntax Tree)に触れたことのない方を対象にしたASTの入門記事です。

そもそもASTとは何なのか、ASTを理解すると何ができるのかを中心に紹介していきます。さっそくですが、タイトルにもある通りまずは1行のコマンドを打ってみましょう。

次のモジュールschema.pyを用意してから、その下にあるpython3コマンドを実行してください。schema.py# このクラスは下記にありました # https://docs.python.org/ja/3/tutorial/classes.html class MyClass: """A simple example class""" i = 12345 def f(self): return 'hello world'$ python3 -c 'import ast; print(ast.dump(ast.parse(open("schema.py").read()), indent=4))'コマンドを実行すると、次のように出力されます。(この結果はPython3.9で実行したものです)

先ほどのschema.pyとよく見比べてみると、見た目は違いますがなんとなくソースコードと同じものを表現していることがわかると思います。また、ModuleやClassDef、ExprなどがPythonのクラス名だとすると、この結果はPythonのオブジェクトにも見えてきます。Module( body=[ ClassDef( name='MyClass', bases=[], keywords=[], body=[ Expr( value=Constant(value='A simple example class')), Assign( targets=[ Name(id='i', ctx=Store())], value=Constant(value=12345)), FunctionDef( name='f', args=arguments( posonlyargs=[], args=[ arg(arg='self')], kwonlyargs=[], kw_defaults=[], defaults=[]), body=[ Return( value=Constant(value='hello world'))], decorator_list=[])], decorator_list=[])], type_ignores=[])もうお気づきだと思いますが、これこそがPythonのASTオブジェクトです。このようにAST(抽象構文木)とは、文字列であるソースコードを解析し、それを木構造で表現したものです。

つまり、Pythonがプログラムを実行する際には、次のような処理が動いてます。

- ソースコードを解析してASTオブジェクトが生成される

- ASTオブジェクトからコードオブジェクトが生成される

- コードオブジェクトから実行可能なバイトコードが生成され、実行される

PythonのASTの見方

ここまででASTとはソースコードと実行可能なバイトコードの中間表現であることは何となく理解できたと思います。

それではもう少しASTオブジェクトの中を見ていきましょう。まずはそのために必要となる道具の紹介です。標準ライブラリのastモジュール

Pythonの標準ライブラリには、ASTオブジェクトを扱うのに便利なastモジュールがあります。

先ほど実行したコマンドでも、次の2つのヘルパー関数を利用していました。

ここではどちらも一言で説明していますので、詳細は公式ドキュメントのリンクを見てください。$ python3 -c 'import ast; print(ast.dump(ast.parse(open("schema.py").read()), indent=4))'

- ast.parse(): 渡されたソースを解析してASTオブジェクトを返します

- ast.dump(): 渡されたASTオブジェクトの木構造を見やすくダンプします

また、先ほどのコマンド出力結果にあった

ClassDefやExpr、Assignといったキーワードはすべてast.ASTクラスのサブクラスです。定義されているサブクラスの一覧は公式ドキュメントの抽象文法を見るとわかります。抽象文法の左辺のシンボルひとつずつにクラスがあり、右辺にあるコンストラクタはそれぞれ左辺のシンボルのサブクラスです。ASTオブジェクトを読み解く

これで必要なものが揃ったので実際にASTを見ていきましょう。

ただし、先ほどの出力結果だと大きすぎるので、ここではx=1というとてもシンプルなPythonのソースコードのASTオブジェクトを見ていきます。$ python3 -c 'import ast; print(ast.dump(ast.parse("x=1"), indent=4))' Module( body=[ Assign( targets=[ Name(id='x', ctx=Store())], value=Constant(value=1))], type_ignores=[])

Moduleは先ほどもあったのでここでは無視すると、x=1を表現しているのはAssignのところです。Assign( targets=[ Name(id="x", ctx=Store()) ], value=Constant(value=1) )Assignは名前からわかる通り代入(assignment)を表現するノードです。

代入の左辺にあたるものがtargetsに、右辺にあたるものがvalueにそれぞれ格納されています。1したがって、代入の左辺xを表現しているノードはName(id="x", ctx=Store())だとわかります。

Nameの引数ctxは、変数の格納、読み込み、削除と対応していて、それぞれStore()、Load()、Del()となっています。右辺1は定数なのでそのままConstant(value=1)ですね。これでこのASTオブジェクトが

x=1という式を表していることが理解できたと思います。この記事の最初のコマンド結果のASTオブジェクトも、同じようにastモジュールのドキュメントを片手にひとつずつ見ていくと読み解けるでしょう。ASTオブジェクトの活用

ASTオブジェクトは先ほども述べたようにソースコードと実行可能なバイトコードの中間表現です。

それでいてPythonオブジェクトでもあるため、ソースコードやコードオブジェクトよりもPythonのプログラムから処理しやすいです。そのため、ASTオブジェクトは様々な活用方法があります。例をあげるとmypyやflake8といった静的解析ツールなどで利用されていたり、pytestではassert文のASTオブジェクトを変更しassert文をより便利なものにしています。そのほかにも、通常のPythonのソースコードではないファイルからASTオブジェクトを生成してPythonのオブジェクトとして動かすこともできます。2

また、Python3.9で追加されたast.unparse()を使うと、ASTオブジェクトからソースコードを生成できます。これを利用してJSONファイルからASTオブジェクトを構築し、pydanticのモデルクラスを生成するライブラリpydantic-generatorを作成しました。もしよかったら触ってみてください。

最後に注意

ASTオブジェクトの変更はユーザーや他の開発者の思いもしない挙動となり、混乱を生じさせる可能性が高いです。

それ以外の方法がないというとき以外は使わないようにしましょう。3おわりに

わたし自身もそうでしたが、ASTは難しいという印象を持っている方も多いのではないでしょうか。

しかし、蓋を開けてみればドキュメントも1ページだけですし、ソースコードと1対1で対応しているためとてもシンプルなものです。

便利なこの1行でいろんなモジュールのASTオブジェクトを眺めてみてください。$ python3 -c 'import ast; print(ast.dump(ast.parse(open("YourFile.py").read()), indent=4))'明日はリサーチチームの@k_ishiさんです。

2020年のRevComm Advent Calendarは一日も途切れることなく続いてますので、明日もお楽しみに!

- 投稿日:2020-12-18T20:24:38+09:00

Raspberrry Pi4 でやってみた機械学習

Raspberrry Pi4 でやってみた機械学習

はじめに

今回、会社で学習用に存在した、Raspberrry Pi4を使ってインストールから解析するまでの説明をさせていただこうかなと思います。

やってみた流れは以下のようになります。

- インストールから起動まで

- SSHとRemote Desktop接続

- Coral AcceleratorとRaspberry Piカメラを使って画像解析とリアルタイム映像解析

インストールから起動まで

準備したもの

- Raspberry Pi 4 Model B(8GB基盤)

- SDカード(Sandisk Ultra 256GB)

- SD カードリーダー

- Type-C電源アダプターとスイッチ

- ケース

- MicroHDMI-to-HDMIケーブル

- Coral USB Accelerator

- Raspberry Piカメラ

- モニター、USBキーボード、USBマウス

- Macパソコン

- Wi-Fi(無線LAN)

ダウンロードとインストール

Mac(Pro)を使用してRaspberry Pi環境をmicroSDカードにインストールします。

OS は従来 Raspbian と呼ばれていた Raspberry Pi OS を利用します。

Raspberry Pi公式サイトに提供してるRaspberry Pi Imager を利用するため、イメージファイルを事前にダウンロードしておく必要はありません。以下の手順の通りに実行します。

Raspberry Pi Imager のインストール

MacOSだと

brew cask install raspberry-pi-imagerでインストール可能ですが、今回は公式サイトから「Raspberry Pi Imager for macOS」をダウンロードしてインストールします。Raspberry Pi OS をSDカードにインストール

SD カードリーダーに microSD カードをセットし、スタートメニューから Raspberry Pi Imager を起動します。

CHOOSE SD CARD で書き込む microSD カードを選択し、 CHOOSE OS をクリックします。

OS を選択すると、自動でイメージをダウンロードできます。

WRITE ボタンを押すと、書き込みが開始されます。

書き込みが完了すると、自動的にベリファイが走ります。

しばらく待って、ベリファイが完了するとSDカードにRaspbianのインストールが完了です。

※Raspberry Pi Imagerを使うと、他のツールを利用する必要が無いため、非常に便利です。SSHとRemote Desktop接続

初期設定として、自分のMacからSSHとRemote Desktopが実行できるように準備します。

理由はモニター、USBキーボード、USBマウスの切替が面倒なので、モニターに繋がず、自分のMac上でRaspberry Piを利用するためです。起動と接続

次に、以下の手順を実行していきます。

Raspbianを書き込んだmicroSDカードをRaspberry Pi4に挿入します。

初回のみ、HDMIケーブルをRaspberry Piに接続し、電源を入れて起動します。

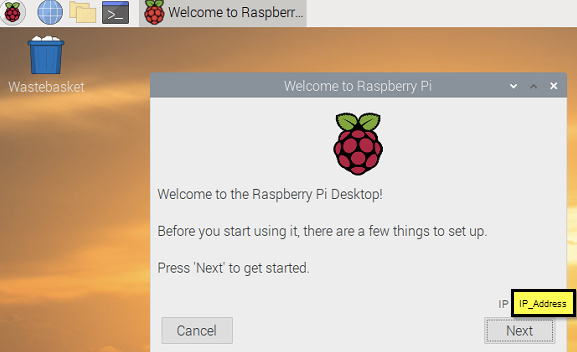

起動シーケンスの後でログイン出来たら、以下の初期インストールを実行します。「Welcome to the Raspberry Pi Deskop!」が表示したら「Next」を押します。

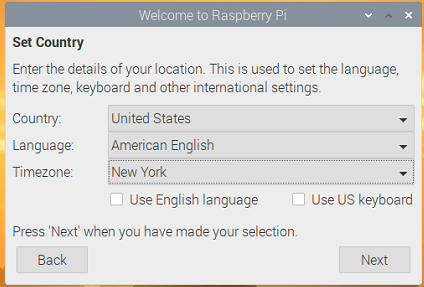

「国、言語、キーボードタイプ、タイムゾーンなど」をセットし、「Next」を押します。

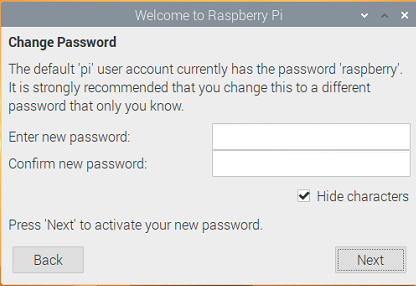

初期ユーザーとパスワードは pi と raspberry になっています、ここでは、新しいパスワードを設定し、「Next」を押します。

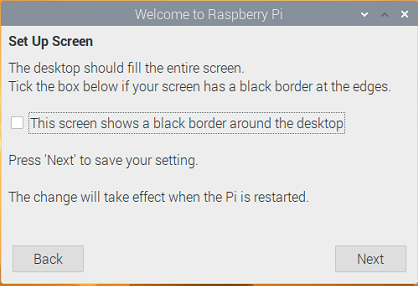

スクリーン設定画面で「This screen shows a black border around the desktop」をオンにして「Next」を押します(再起動してから反映されます)。

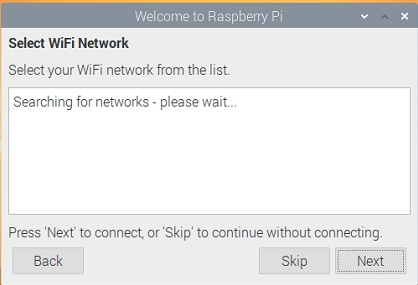

Wi-Fiネットワークを設定し、「Next」を押します。

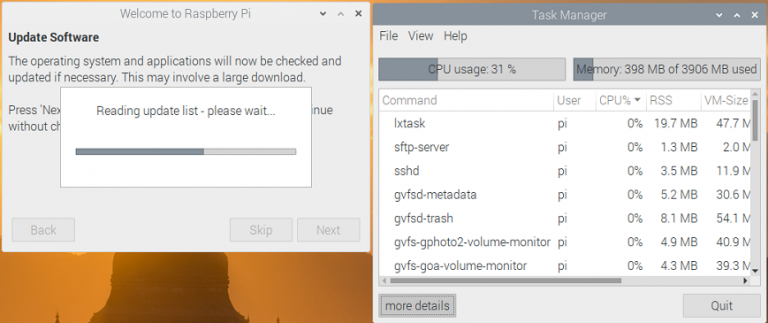

ソフトウェアの更新画面でスキップしてもいいですが、アップデートした良いので、「Next」を押します。

アップデート中にタスクマネージャーを開くと、プロセスを確認出来ます。

アップデートが完了したら、「Restart」を押して再起動を行います。

初期設定と接続設定

OS バージョン確認

pi@raspberrypi:~ $ uname -a Linux raspberrypi 5.4.79-v7l+ #1373 SMP Mon Nov 23 13:27:40 GMT 2020 armv7l GNU/Linuxパッケージ更新

pi@raspberrypi:~ $ sudo apt update pi@raspberrypi:~ $ sudo apt upgrade -yvim インストール

pi@raspberrypi:~ $ sudo apt install vim -yraspi-config による設定

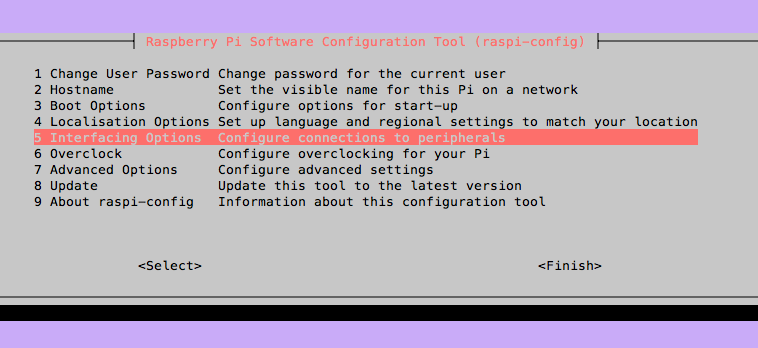

pi@raspberrypi:~ $ sudo raspi-config次のようなキャラクタベースのUIが起動します。

「5 Interfacing Options」を選択して、「P2 SSH」を選択しSSHを有効化と、「P3 VNC」を選択しVNCを有効化します。

※VNCが表示されない場合、以下のように手動でインストールしてください。pi@raspberrypi:~ $ sudo apt update pi@raspberrypi:~ $ sudo apt install realvnc-vnc-server realvnc-vnc-viewerその後、以下のコマンドで再起動させます。

pi@raspberrypi:~ $ sudo rebootVNC Viewerの設定

Raspberry Pi に割り振られた、private IPアドレスを調べます。pi@raspberrypi:~ $ ifconfig もしくは pi@raspberrypi:~ $ ping raspberrypi.localVNC Viewerを起動します。

VNC Viewerの検索ボックスに、Raspberry Piに割り振られたprivate IPアドレスを入力します。

「Connect to address」を押してRaspberry Piのユーザーとパスワードを入れます。

問題なく設定出来たらトップバーにアイコンが表示されます。

ついでに、画面解像度が良くなるように設定します。pi@raspberrypi:~ $ sudo vim /boot/config.txt ===== これを追加します。 hdmi_ignore_edid=0xa5000080 hdmi_group=2 hdmi_mode=85 =====次はRaspberry Piをsleepしないように設定します。

方法は2つあります。

方法1pi@raspberrypi:~ $ sudo vim /etc/lightdm/lightdm.conf ===== これを追加します。 xserver-command=X -s 0 -p 0 -dpms =====方法2

pi@raspberrypi:~ $ sudo apt-get install xscreensaverpreferenceからscreensaverに行って、Display ModesタグのModeをDisable Screen Saverを選択します。その後、再起動させます。

自分のMacからSSHで接続する

自分のMacの「ターミナル」に以下のコマンドを入力します。

IPのところにRaspberry Piに割り振られたprivate IPアドレスを入力します。[~]$ ssh pi@192.168.0.107自分のMacから画面共有アプリケーションで接続する

自分のMacの「Screen Sharing」画面共有アプリを開きます。

接続先の入力部に、Raspberry Piに割り振られたprivate IPアドレスを入力し、接続を押します。

パスワードの入力部に、ログインパスワードを入力しサインインを押します。(パスワードを保存するチェックボックスをオンにすると次回入力が楽になります。)

以下のように、raspberrypiの画面が表示されます。

CoralAcceleratorとRaspberry Piカメラを使って画像解析とリアルタイム映像解析

Raspberry Piにセットアップする

初めに、CoralAcceleratorの「Get started」を行います。

Coral USB AcceleratorをRaspberry Piに繋げます。

その後、以下の手順を実行します。pi@raspberrypi:~ $ echo "deb https://packages.cloud.google.com/apt coral-edgetpu-stable main" | sudo tee /etc/apt/sources.list.d/coral-edgetpu.list pi@raspberrypi:~ $ curl https://packages.cloud.google.com/apt/doc/apt-key.gpg | sudo apt-key add - pi@raspberrypi:~ $ sudo apt-get update次に、Edge TPUランタイムをインストールします。

pi@raspberrypi:~ $ sudo apt-get install libedgetpu1-std次に、Raspberry PiカメラをRaspberry Piに繋げます。

その後、以下の手順を実行して、サンプル用に写真を撮ります。

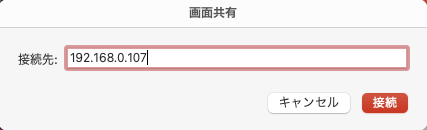

Raspberry Pi Configurationを開きます。

Interfacesタブからcameraをenabledにします。

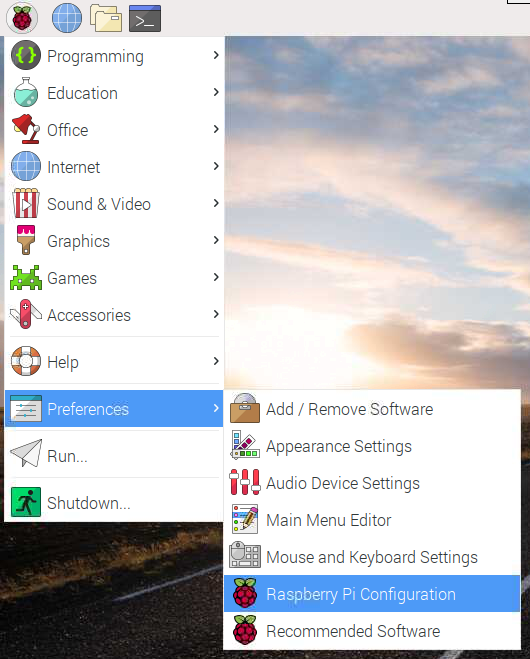

次のコマンドで写真を撮ります。pi@raspberrypi:~ $ raspistill -o Desktop/image.jpg画像解析しましょう

これらの手順に従って、Coralが提供しているコンパイル済みのモデルとサンプルスクリプトを使用して、画像分類を実行します。

まずは、GitHubからダウンロードを行います。pi@raspberrypi:~ $ mkdir coral && cd coral pi@raspberrypi:~ $ git clone https://github.com/google-coral/tflite.git鳥の分類モデル、ラベルファイル、と鳥の写真をダウンロードします。

pi@raspberrypi:~ $ cd tflite/python/examples/classification pi@raspberrypi:~ $ bash install_requirements.sh以下の鳥の写真を使用して画像分類子を実行します。

pi@raspberrypi:~ $ python3 classify_image.py \ --model models/mobilenet_v2_1.0_224_inat_bird_quant_edgetpu.tflite \ --labels models/inat_bird_labels.txt \ --input images/parrot.jpgリアルタイム映像解析

今回は、Coralが提供しているサンプルの中から「Image recognition with video」をRaspberry Piカメラを利用して、リアルタイム映像解析を行います。

まずは、GitHubからダウンロードします。pi@raspberrypi:~ $ mkdir google-coral && cd google-coral pi@raspberrypi:~ $ git clone https://github.com/google-coral/examples-camera --depth 1モデルをダウンロードします。

pi@raspberrypi:~ $ cd examples-camera pi@raspberrypi:~ $ sh download_models.shgstreamerライブラリをインストールします。

pi@raspberrypi:~ $ cd gstreamer pi@raspberrypi:~ $ bash install_requirements.shそして、デモを実行します。

pi@raspberrypi:~ $ python3 classify_capture.pyiPadで画像を表示して認識します。

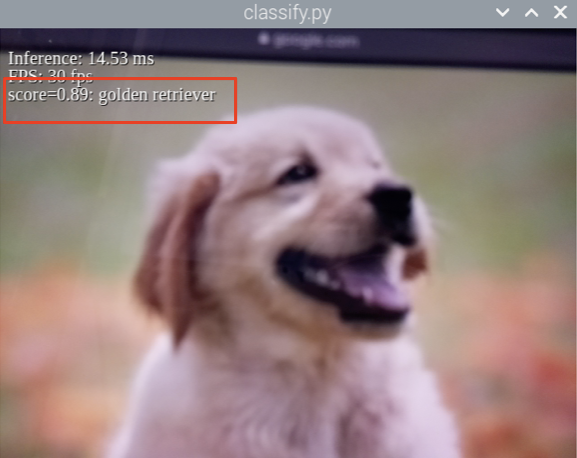

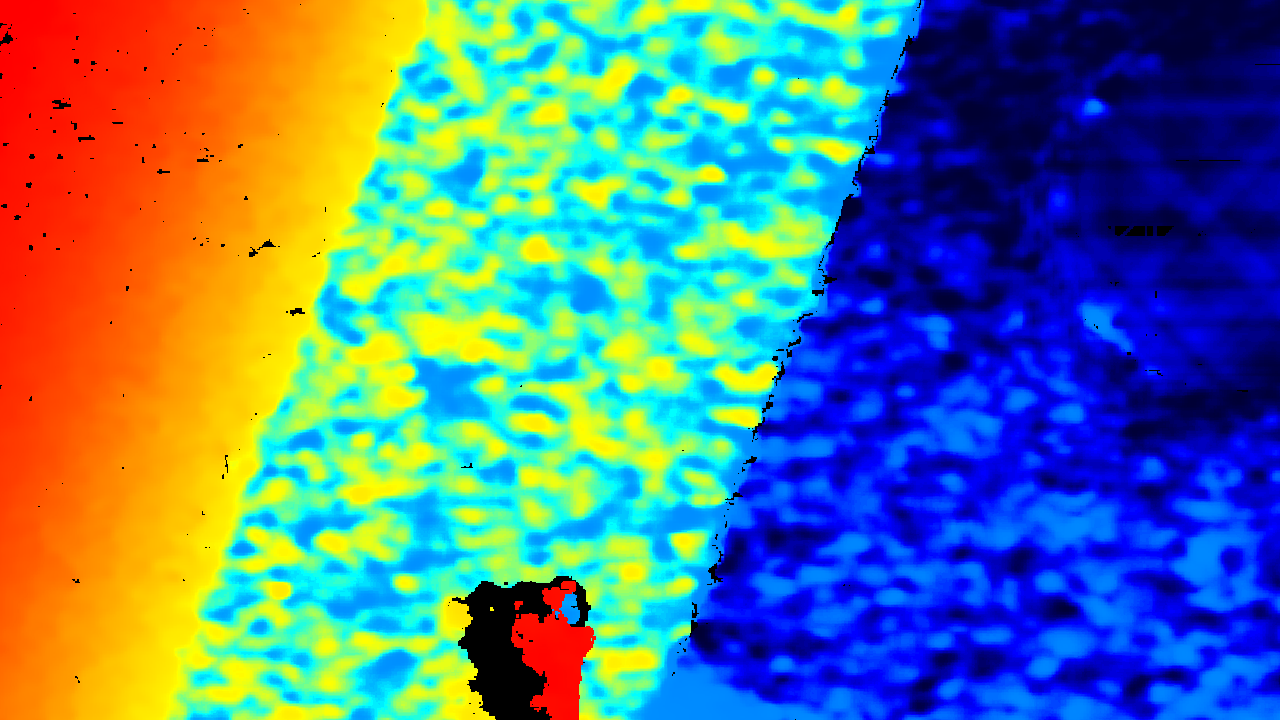

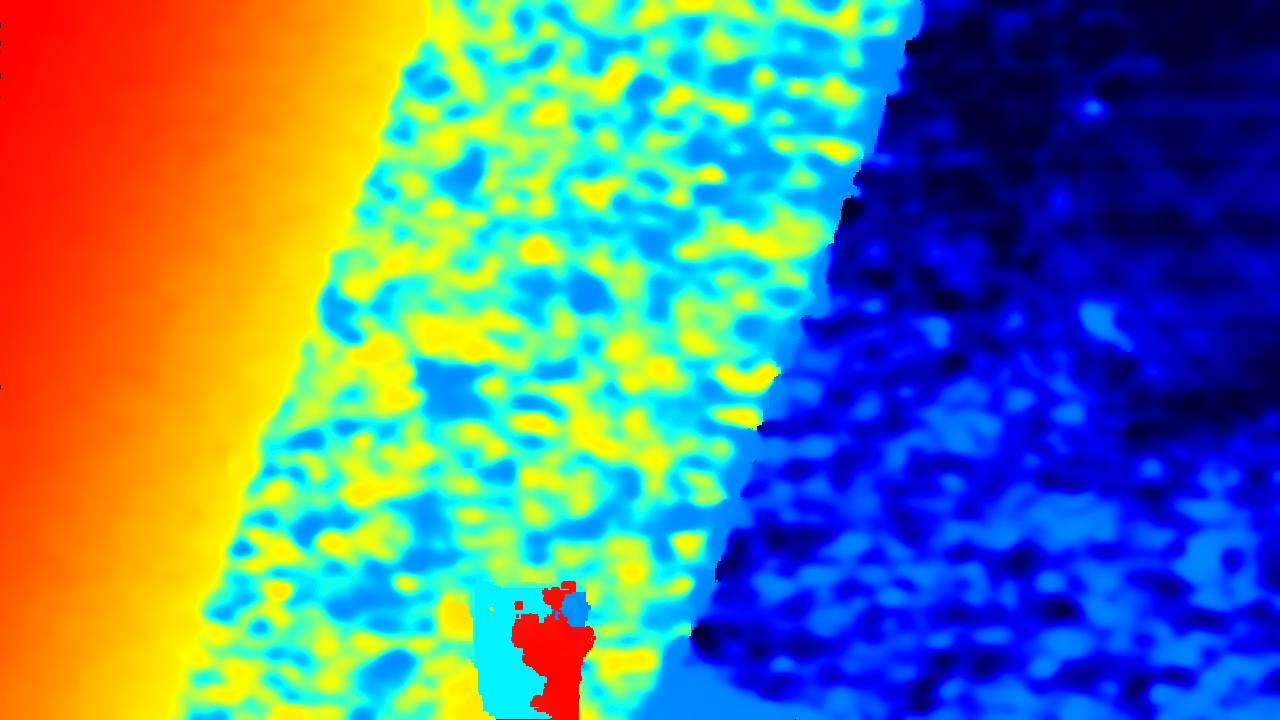

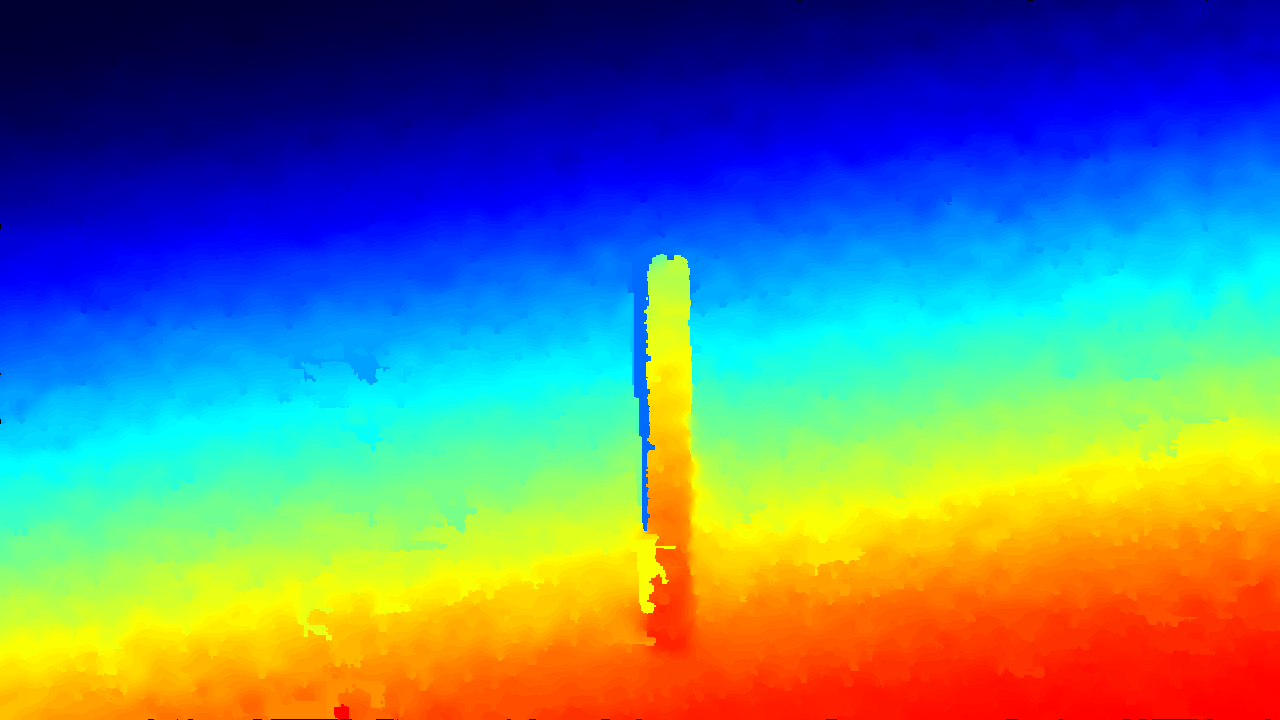

結果として、以下の画像が得られました。

得られた名前で検索を行い、結果が正しいことが確認できました。

以上で、学習結果の説明は終了となります。

- 投稿日:2020-12-18T20:13:51+09:00

YouTubeのPython解説を覚え書き。

Learn Python - Full Course for Beginners [Tutorial]

https://www.youtube.com/watch?v=rfscVS0vtbw

(英語字幕は ところどころ間違っているので 注意が必要。)

2:14 -

python download

https://www.python.org/downloads/

Python 3 or Python 2?

Python 3 は 今後も利用されていくバージョンで、サポートもされているため、このコースではこちらを利用します。

Python 3 は 初心者が学ぶのに適しています。

(2020-12-18 現在、Python 3.9.1 のみ ダウンロードリンクがあった。)次のインストール中のオプション 2つ:

Add Python 3.9 to PATH

Disable path length limit

これらは どちらも設定せずに インストールを完了するといいらしいです。(参考: https://gammasoft.jp/python/python-install-on-windows/)

4:53 -

Choose text editor

IDE - integrated development environment

PyCharm Community Edition を ダウンロードする。(現在 最新バージョンは 2020.3)

https://www.jetbrains.com/ja-jp/pycharm/download/#section=windowsinstallation Options

通常は何もチェックしなくて構いませんが、必要な場合は適宜チェックしてください。(参考: https://gammasoft.jp/python/pycharm-install-on-windows/)

6:42 -

Setup & Hello World7:07 -

動画内の旧バージョンのPyCharmでは 右下にConfigureのメニューがあるが、最新版の2020.3では 画面左 Customizeタブの "All settings..." から 設定ができるみたい。

また、動画ではAppearanceのThemeをDarculaに変更していたが、最新版ではデフォルトからDarculaだった。7:49 -

動画内では"Interpreter: "というオプションだけだが、最新版の初回起動時では New enviroment using: Virtualev と なっており、Base interpreterが"...Python39\python.exe"になっていれば良いようだ。

- 投稿日:2020-12-18T19:51:38+09:00

【Xonsh】Python製シェルが尖りまくってて神

Macのターミナル環境を色々改造しつつその一環としてshellも何個か見てきました。

bash, zsh, fish ...中でもここ半年くらいはPython製のXonshが超絶お気に入りなので自分なりに紹介します。

ちなみに元ネタと言うか見つけたきっかけは、機械学習界隈で有名なばんくしさんのブログです。

Python製シェルxonshを半年使った所感や環境設定のまとめ

この人すごすぎ

What's Xonsh

タイトルのまんまですが、Pythonで作られたShellです。

Pythonで作られ、Pythonで動き、Pythonが実行できます。他のシェルが何で動いてるかとかはわかりませんが、とにかくこいつが超尖っててイケてます。

Commnd and Python

Pythonで作られている事のメリットその1として、コマンドとPythonスクリプトの同居ができます。

[ ~/Desktop/tmp ] $ ls -al Permissions Size User Date Modified Name drwxr-xr-x - *** 18 12 19:20 . drwx------ - *** 18 12 19:18 .. [ ~/Desktop/tmp ] $ dirs = ['a', 'b', 'c'] [ ~/Desktop/tmp ] $ for dir in dirs: . mkdir @(dir) . [ ~/Desktop/tmp ] $ ls -al Permissions Size User Date Modified Name drwxr-xr-x - *** 18 12 19:21 . drwx------ - *** 18 12 19:18 .. drwxr-xr-x - *** 18 12 19:21 a drwxr-xr-x - *** 18 12 19:21 b drwxr-xr-x - *** 18 12 19:21 cこんな感じ。

わざわざ変数に入れてfor文回すよりmkdir × 3の方がはえーよ!!と思うかもしれませんが、

処理がえぐいくらい増えた時とかこれ使ったらめちゃくちゃイケてると思いませんか?当然のごとく関数だって定義できちゃいます。

[ ~/Desktop/tmp ] $ def hello_xonsh(): . print('hello xonsh !!!') . [ ~/Desktop/tmp ] $ hello_xonsh() hello xonsh !!!.xonshrc

他のシェル同様、xonshにもrcファイルがあります。(.xonshrc)

もう想像ついてるかもしれませんが、このrcファイルが全てPythonで記述できます。個人的にはこれが神すぎて使ってる

- Aliases