- 投稿日:2020-01-13T23:52:39+09:00

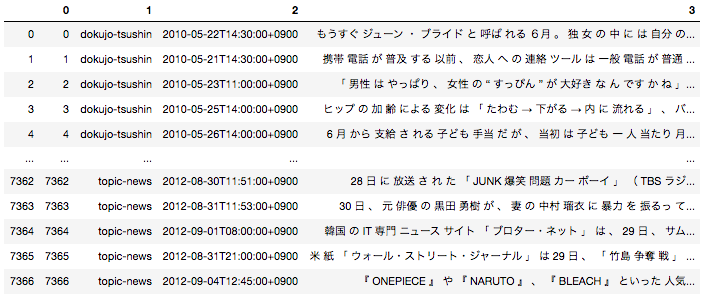

[Python3 入門 8日目] 4章 Pyの皮:コード構造(4.1〜4.13)

4.1 #によるコメント

- プログラムの中に含まれるテキストで"#"によるコメントはPythonインタープリンタから無視される。

- Pythonには複数行コメントはないため、コメント行、コメントセクションの冒頭には必ず#を入れなければならない。

4.2 \による行の継続

- 行末に\を置くとPythonはまだ行替えをしていないと思って動く。

#小さい文字列から長い文字列を作りたければ次のように少しずつ作っていく方法がある。 >>> alphabet = "" >>> alphabet +="abcdefg" >>> alphabet +="hijklmnop" >>> alphabet +="qrstuv" >>> alphabet +="wxyz" #継続文字を使えば見づらくせずワンステップで作ることもできる。 >>> alphabet = "abcdefg" + \ ... "hijklmnop" +\ ... "qrstuv"+\ ... "wxyz" #行が複数行にまたがる場合にも行継続が必要になる。 >>> 1+2+ File "<stdin>", line 1 1+2+ ^ SyntaxError: invalid syntax >>> 1+2\ ... 3 File "<stdin>", line 2 3 ^ SyntaxError: invalid syntax >>> 1+2+\ ... 3 64.3 if, elif,elseによる比較

- Pythonではセクション内ではコードが首尾一貫しているはずだと考えて動くため、インデントは同じ大きさで左端が揃っていなければならない。

- PEP8という推奨スタイルは4個のスペースを使っている。

#disasterの内容をチェックして適切なコメントを表示するプログラム >>> disaster = True >>> if disaster: ... print("Woe!") ... else: ... print("Whee!") ... Woe!>>> funny = True >>> small = True #if funnyがTrueならば if smallのテストに入る。 >>> if funny: ... if small: ... print("It's a cat.") ... else: ... print("It's a bear!") ... else: ... if small: ... print("It's a skink!") ... else: ... print("It's a human.Or a hairless bear.") ... It's a cat.#テストが3種類以上に分かれる場合はif,elif(else ifという意味),elseを使う。 >>> color ="puse" >>> if color =="red": ... print("It's a tomato") ... elif color =="green": ... print("It's a green pepper") ... elif color =="bee purple": ... print("I don't know what it is,but only bees can see it") ... else: ... print("I've never heard of the color",color) ... I've never heard of the color puse>>> x =2 #等価性のテスト >>> x ==2 True >>> x ==5 False >>> 4 < x False >>> x<10 True #ブール演算子は比較対象の要素よりも優先順位が低い。 #比較対象となる要素が先に計算されてからブール演算子が行われる。 >>> 1<x and x <10 True >>> 1<x or x <10 True >>> 1<x and x >10 False >>> 1<x and not x >10 True >>> 1<x<10 True >>> 1<x<10<377 True4.3.1 Trueとは何か

- 以下に示すものは全てFalseと見なされる。

- その他のものは全てTrueと見なされる。

Falseと見なされるもの 値 ブール値 False null None 整数のゼロ 0 floatのゼロ 0.0 空文字列 " " 空リスト [ ] 空タプル ( ) 空辞書 { } 空集合 set() >>> some_list = [] >>> if some_list: ... print("There's something in here") ... else: ... print("Hey,it's empty!") ... Hey,it's empty!4.4 whileによる反復処理

- 同じことを2回以上行いたいときはループを使う。

#countの初期化 #countの値と5を比較 #countを1ずつインクリメント(加算) >>> count =1 >>> while count <=5: ... print(count) ... count+=1 ... 1 2 3 4 54.4.1 ブレイクによるループの中止

- ループを中止させたい場合、breakを使う

#無限ループ #input()関数を使ってキーボードから入力行を読み出し、stuffに代入 #入力文字が"q":だった場合にループを抜ける。 #"q"以外は入力文字列の先頭文字を大文字にして表示する。 >>> while True: ... stuff=input("String to capitalize[type q to quit]:") ... if stuff == "q": ... break ... print(stuff.capitalize()) ... String to capitalize[type q to quit]:type Type String to capitalize[type q to quit]:untitarou Untitarou String to capitalize[type q to quit]:q4.4.2 continueによる次のイテレーションの開始

- イテレーションとは反復処理の1回分のことである。

#input()関数を使ってキーボードから入力行を読み出し、valueに代入 #入力文字が"q":だった場合にループを抜ける。 #valueをint型にしてnumberへ代入 #偶数であれば次のイテレーションを開始 >>> while True: ... value=input("Integer,please [q to quit]:") ... if value == "q": ... break ... number =int(value) ... if number %2==0: ... continue ... print(number,"squared is",number*number) ... Integer,please [q to quit]:1 1 squared is 1 Integer,please [q to quit]:2 Integer,please [q to quit]:3 3 squared is 9 Integer,please [q to quit]:q4.4.3 elseによるbreakのチェック

#変数positionの初期化 #偶数であれば"Found even numbers"とその数字を表示させbreakでwhile文を抜ける。 #else節はwhile分が終了したが探し物が見つからなかった場合に実行される。(breakチェッカー) >>> number =[1,3,5] >>> position =0 >>> while position <len(number): ... numbers=number[position] ... if numbers%2 ==0: ... print("Found even numbers",numbers) ... break ... position+=1 ... else: ... print("No even number found") ... No even number found4.5 forによる反復処理

Pythonはイテレータ(イテレーションごとにリスト、辞書などから要素を一つずつ取り出して返すもの)を頻繁に使う。

それはデータ構造を知らなくてもデータ構造の各要素を操作できるから。#while文 >>> rabbits =["a","b","c","d"] >>> current=0 >>> while current<len(rabbits): ... print(rabbits[current]) ... current +=1 ... a b c d #for文 >>> for rabbit in rabbits: ... print(rabbit) ... a b c dリスト、文字列、タプル、辞書、集合、その他とともにPythonのイテラブル(イテレータに対応している)オブジェクトである。

- タプルやリストをforで処理すると一度に一つずつの要素が取り出される。

- 文字列をforで処理すると以下に示すように一度に一つずつ文字が生成される。

>>> word="cat" >>> for letter in word: ... print(letter) ... c a t

- 辞書をforで処理するとキーが返される。

>>> accusation ={"a":"ballroom","b":"weapon","c":"kowai"} >>> for card in accusation: ... print(card) ... a b c

- 値を反復処理させたい場合は辞書のvalues()関数を使う。

>>> for value in accusation.values(): ... print(value) ... ballroom weapon kowai

- キーと値の両方をタプルの形で帰したい場合はitems()関数を使う。

>>> for value in accusation.items(): ... print(value) ... ('a', 'ballroom') ('b', 'weapon') ('c', 'kowai')

- タプルの各要素を個別の変数に代入したい場合は、forの変数を2つ用意する。第一引数に"キー"、第二引数に"値"が代入される。

>>> for card,contents in accusation.items(): ... print("Card",card,"has the contents",contents) ... Card a has the contents ballroom Card b has the contents weapon Card c has the contents kowai4.5.1 breakによる中止

for文の中にbreak文を入れるとwhile分と同様にループを中止できる。

4.5.2 continueによる次のイテレーションの開始

for文にcontinueを入れるとwhile分と同様に次のイテレーションにジャンプする。

4.5.3 elseによるbreakのチェック

whileと同様にforは正常終了したかどうかをチェックするオプションのelseを持っている。breakが呼び出されなければ、else文が実行される。

>>> cheeses=[] >>> for cheese in cheeses: ... print("This shop has some lovely",cheese) ... break ... else: ... print("This is not much of a cheese shop,is it?") ... This is not much of a cheese shop,is it?4.5.4 zip()を使った複数のシーケンス処理

- zip関数を使えば複数のシーケンスを並列的に処理できる。

- zip()は最もサイズが小さいシーケンス要素を処理しつくし時に止まる。

#リストの作成 #dessertsだけが他のリストより長い。他の要素を長くしない限りpuddingをもらえる人はいない。 >>> days =["Monday","Tuesday","Wednesday"] >>> fruits=["coffee","tea","bear"] >>> drinks=["coffee","tea","beer"] >>> desserts=["tiamisu","ice cream","pie","pudding"] #zip()を使い、複数のシーケンスをたどってオフセットが共通する要素からタプルを作ることができる。 >>> for day,fruit,drink,dessert in zip(days,fruits,drinks,desserts): ... print(day,":drink",drink,"- eat",fruit,"-enjoy",dessert) ... Monday :drink coffee - eat coffee -enjoy tiamisu Tuesday :drink tea - eat tea -enjoy ice cream Wednesday :drink beer - eat bear -enjoy pie#zip()から返される値自体はタプルやリストではなく、タプルやリストにできるイテラブルな値である。 >>> english="Monday","Tuesday","Wednesday" >>> french="Lundi","Mardi","Mercredi" #リスト化 >>> list(zip(english,french)) [('Monday', 'Lundi'), ('Tuesday', 'Mardi'), ('Wednesday', 'Mercredi')] #辞書化 >>> dict(zip(english,french)) {'Monday': 'Lundi', 'Tuesday': 'Mardi', 'Wednesday': 'Mercredi'}4.5.5 range()による数値シーケンスの生成

- range()関数を使えば指定した範囲の数値ストリームを返すことができる。

- range()はrange(start: end:step)というスライスと似た形式で使う。 startは省略すると0が先頭になる。唯一の引数はendで、スライスと同様に作成される最後の値はstep-1の値である。 stepのデフォルト値は1だが、−1を指定して逆順にすることができる。

- zip()と同様にrange()はイテラブルなオブジェクトを返すので戻り値はfor...inで反復処理するか、リストなどのシーケンスに変換するが必要ある。

#0から3までの範囲作成 >>> for x in range(0,3): ... print(x) ... 0 1 2 #リスト化 >>> list(range(0,3)) [0, 1, 2] #2から0までの範囲作成 >>> for x in range(2,-1,-1): ... print(x) ... 2 1 0 #リスト化 >>> list(range(2,-1,-1)) [2, 1, 0] #0から10までの偶数を取り出し >>> list(range(0,11,2)) [0, 2, 4, 6, 8, 10]4.6 内包表記

内包表記は一つ以上のイテレータからPythonデータ構造をコンパクトに作れる形式。

4.6.1 リスト内包表記

1から5までの整数のリストは以下のように一つずつ要素を追加しても作れる。

#append()を使い末尾に追加している。 >>> number_list=[] >>> number_list.append(1) >>> number_list.append(2) >>> number_list.append(3) >>> number_list.append(4) >>> number_list.append(5) >>> number_list [1, 2, 3, 4, 5] #range()関数とforでも作れる。 >>> number_list=[] >>> for number in range(1,6): ... number_list.append(number) ... >>> number_list [1, 2, 3, 4, 5] #range()の出力を直接リストに変換しても作れる。 >>> number_list = list(range(1,6)) >>> number_list [1, 2, 3, 4, 5]リスト内包表記を使ったコードを以下に示す。

#[expression for item in iterable]の基本形式 #最初のnumber変数はループの実行結果をnumber_listに格納するためのもの。 #第二のnumberはfor文の一部 >>> number_list = [number for number in range(1,6)] >>> number_list [1, 2, 3, 4, 5] #最初のnumberが式だとわかる。 >>> number_list = [number-1 for number in range(1,6)] >>> number_list [0, 1, 2, 3, 4]>>> a_list=[] >>> for number in range (1,6): ... if number%2 ==1: ... a_list.append(number) ... >>> a_list [1, 3, 5] #[expression for item in iterable if condition]の形式 >>> a_list = [number for number in range(1,6) if number %2 ==1] >>> a_list [1, 3, 5]>>> rows =range(1,4) >>> cols=range(1,3) >>> for row in rows: ... for col in cols: ... print(row,col) ... 1 1 1 2 2 1 2 2 3 1 3 2 #内包表記もネストできる。 #タプルで出力している。 >>> rows =range(1,4) >>> cols=range(1,3) >>> cells = [(row,col) for row in rows for col in cols] >>> for cell in cells: ... print(cell) ... (1, 1) (1, 2) (2, 1) (2, 2) (3, 1) (3, 2) #cellsリストを反復処理しながらタプルからrow,colを引き抜く。 >>> for row,col in cells: ... print(row,col) ... 1 1 1 2 2 1 2 2 3 1 3 24.6.2 辞書包括表記

- 辞書にも内包表記がある。

- {key_item:value_item for item in iterable}の基本形式

#"letters"から一つずつ文字を取り出し"letters"の中に何個含まれているかカウントし、キーとカウント回数をletter_countsに格納 >>> word ="letters" >>> letter_counts={x:word.count(x)for x in word} >>> letter_counts {'l': 1, 'e': 2, 't': 2, 'r': 1, 's': 1} #wordを集合としてみる。 >>> word ="letters" >>> letter_counts={x:word.count(x)for x in set(word)} >>> letter_counts {'e': 2, 'l': 1, 's': 1, 't': 2, 'r': 1}4.6.3 集合内包表記

- {item for item in iterable}の基本形式

- 集合でも長いバージョンが使える。

>>> a_set={number for number in range(1,6) if number %3 ==1} >>> a_set {1, 4}4.6.4 ジェネレータ内包表記

- タプルに内包表記はない

- 普通のかっこで内包表記を作るとジェネレータオブジェクトを返す

- ジェネレータとはイテレータにデータを供給する方法の一つ。

#()間のものはジェネレータ内包表記 >>> number_thing = (number for number in range(1,6)) #ジェネレータオブジェクトを返す。 >>> type(number_thing) <class 'generator'> #ジェネレータオブジェクトはfor文で処理できる。 >>> for number in number_thing: ... print(number) ... 1 2 3 4 5 #ジェネレータ内包表記をlist()呼び出しでラップすればリスト内包表記リスト包括表記のように動作できる。 >>> number_list=list(number_thing) >>> number_list [1, 2, 3, 4, 5] #ジェネレータは一度だけしか実行できない。ジェネレータは一度に一つずつその場で値を作り、イテレータに渡してしまうので作った値を覚えていない。そのためジェネレータをもう一度使ったりバックアップしたりすることはできない。 >>> number_list=list(number_thing) >>> >>> number_list []4.7 関数

プログラマーは関数に対して二つのことをできる。

- 関数の定義

- 関数の呼び出し

Python関数を定義するには defと入力し、関数名を書き、関数に対する入力引数をかっこに囲んでかき、最後に(:)を書く。

#make_a_sound()関数を呼び出すとPythonが定義の中のコードを実行する。この場合は、1個の単語を出力して、メインプログラムに制御を返す。 >>> def make_a_sound(): ... print("quack") ... >>> make_a_sound() quack #引数がないが値を返す関数 >>> def agree(): ... return True ... >>> agree() True #ifを使って戻り値をテストする。 >>> if agree(): ... print("Splendid!") ... else: ... print("That was unexpected.") ... Splendid!>>> def echo(anything): ... return anything+' '+anything ... #echo()関数は"ss"という実引数とともに呼び出されている。 #この値はecho()内のanithingという仮引数にコピーされ、呼び出し元に返される。 >>> echo("ss") 'ss ss'

関数を呼び出すときに関数に渡される値も引数と呼ばれる。

実引数(argument)を渡して関数を呼び出すとき、それらの値は関数内の対応する仮引数(parameter)にコピーされる。

>>> def commtentary(color): ... if color == "red": ... return "It's a tomoato." ... elif color =="green": ... return "It's a green pepper" ... elif color =="bee purple": ... return "I don't know what it is,but only bees can see it." ... else: ... return "I've never heard of te color"+ color+"." ... #"blue"という実引数とともにcommententary関数を呼び出す。 >>> comment=commtentary("blue") >>> print(comment) I've never heard of te colorblue.

- 関数が明示的にreturnを呼び出さなければ呼び出しもとはNoneを受け取る

>>> def do_nothing(): ... pass ... >>> print(do_nothing()) None

- Noneは何もいうべきことがない時に使われる。

- Noneはブール値として評価すると偽になるが、ブール値のFalseと同じではない。

>>> def is_none(thing): ... if thing is None: ... print("It's nothing") ... elif thing: ... print("It's True") ... else: ... print("It's False") ... >>> is_none(None) It's nothing >>> is_none(True) It's True >>> is_none(False) It's False #ゼロの整数とfloat、空文字列、空リスト、空タプル、空辞書、空集合はFalseだが、Noneとは等しくない。 >>> is_none(0) It's False >>> is_none(0.0) It's False >>> is_none(()) It's False >>> is_none([]) It's False >>> is_none({}) It's False >>> is_none(set()) It's False4.7.1 位置引数

- 位置引数とは先頭から順に対応する位置の仮引数にコピーされる引数

>>> def menu(x,y,z): ... return{"wine":x,"entree":y,"dessert":z} ... >>> menu("aaa","bbb","ccc") {'wine': 'aaa', 'entree': 'bbb', 'dessert': 'ccc'}4.7.2 キーワード引数

- 対応する仮引数の名前を指定して実引数を指定すれば良い。

- 位置引数とキーワード引数の両方を使って関数を呼び出す場合は、まず先に位置引数を指定しなければならない。

>>> def menu(x,y,z): ... return{"wine":x,"entree":y,"dessert":z} ... >>> menu("beef","bagel","bordeaux") {'wine': 'beef', 'entree': 'bagel', 'dessert': 'bordeaux'} #仮引数を指定して実引数を指定している。 >>> menu(y="beef",z="bagel",x="bordeaux") {'wine': 'bordeaux', 'entree': 'beef', 'dessert': 'bagel'} #位置引数とキーワード引数の両方を使う場合は位置引数を最初に指定する。 >>> menu("frontenac",z="flan",y="fish") {'wine': 'frontenac', 'entree': 'fish', 'dessert': 'flan'}4.7.3 デフォルト引数値の指定

#デフォルト引数値の指定 >>> def menu(x,y,z="unchi"): ... return{"wine":x,"entree":y,"dessert":z} ... #"dessert"のみ引数指定されていないためデフォルトの引数が入る。 >>> menu("dunkelfelder","chiken") {'wine': 'dunkelfelder', 'entree': 'chiken', 'dessert': 'unchi'} #引数を指定すればそれがデフォルト値の代わりに使われる。 >>> menu("dunkelfelder","duck","doughnut") {'wine': 'dunkelfelder', 'entree': 'duck', 'dessert': 'doughnut'}>>> def buggy(arg,result=[]): ... result.append(arg) ... print(result) ... >>> buggy("a") ['a'] #['ab']としたい... >>> buggy("ab") ['a', 'ab']#buggy()関数呼びだしのたびにresultを[]にして初期化しておくおkとがポイント >>> def buggy(arg): ... result=[] ... result.append(arg) ... return result ... >>> buggy("a") ['a'] #正しく動作した!!!! >>> buggy("b") ['b']#result=[]としてif文を使い、resultを初期化している。 >>> def nonbuggy(arg,result=None): ... if result is None: ... result = [] ... result.append(arg) ... print(result) ... >>> nonbuggy("a") ['a'] >>> nonbuggy("b") ['b']4.7.4 *による位置引数のタプル化

- 関数定義の中で仮引数の一部として*を使うと、可変個の位置引数をタプルにまとめてその仮引数にセットできる。

- *を使うときにタプル仮引数をargsを使うのが慣習的。

>>> def print_args(*args): ... print("Positional argument tuple:",args) ... >>> print_args() Positional argument tuple: () #argsタプルとして表示される >>> print_args(3,2,1,"wait!","uh...") Positional argument tuple: (3, 2, 1, 'wait!', 'uh...') #必須の引数がある場合には、位置引数の最後に*argsを書くと必須引数以外の全ての位置引数を一つにまとめることができる。 >>> def print_more(x1,x2,*args): ... print("Need this one",x1) ... print("Need this one too",x2) ... print("All the rest",args) ... >>> print_more("cap","gloves","scarf","monocle","mustache wax") Need this one cap Need this one too gloves All the rest ('scarf', 'monocle', 'mustache wax')4.7.5 **によるキーワード引数の辞書化

- **を使えばキーワード引数を1個の辞書にまとめることができる。

- 引数の名前は辞書のキー、引数の値は辞書の値となる。

- 位置引数をまとめるargsと*kwargsを併用する場合、この二つはこの順序でまとめなければならない。

>>> def print_kwargs(**kwargs): ... print("Keyward arguments:",kwargs) ... >>> print_kwargs(x="xx",y="yy",z="zz") Keyward arguments: {'x': 'xx', 'y': 'yy', 'z': 'zz'}**4.7.6 docstring

- 関数本題の先頭に文字列を組み込めば、関数定義にドキュメントをつけることができる。これを関数のdocstringと呼ぶ。

>>> def echo(anything): ... 'echoは与えられた入力引数をかえす' ... return anything ... #help()関数を呼び出すと関数のdocstringを表示する。 >>> help(echo) Help on function echo in module __main__: echo(anything) echoは与えられた入力引数をかえす (END)4.7.7 一人前のオブジェクトとしての関数

- 関数もオブジェクトである。

- 関数はリスト、タプル、集合、辞書の要素として使うことができる。

- 関数はイミュータブルなので辞書のキーとしても使うことができる。

>>> def answer(): ... print(43) ... >>> answer() 43 >>> def run_something(func): ... func() ... #answer()ではなくanswerを渡すと他のデータ型と同様に関数をデータ型として使っていることになる。 >>> run_something(answer) 43>>> def add_args(x1,x2): ... print(x1+x2) ... >>> type(add_args) <class 'function'> #funcをオブジェクトとしてrun_something_with_argsに渡している。 >>> def run_something_with_args(func,arg1,arg2): ... func(arg1,arg2) ... >>> run_something_with_args(add_args,5,9) 14#任意の数の位置引数をとり、sum()関数でそれらの合計を計算して返す。 >>> def sum_args(*args): ... return sum(args) ...>>> def run_with_positional_args(func,*args): ... return func(*args) ... >>> run_with_positional_args(sum_args,1,2,3,4) 104.7.8 関数内関数

- 関数を関数内で定義することができる。

>>> def outer(a,b): ... def inner(c,d): ... return c+d ... return inner(a,b) ... >>> outer(4,7) 11 >>> def knights(s): ... def inner(q): ... return "%s" % q ... return inner(s) ... >>> knights("Ni!") 'Ni!'4.7.9 クロージャ

- 関数内関数はクロージャとして機能する。

- クロージャとは他の関数によって動的に生成される関数で、その関数の外で作られた変数の値を覚えていたり、変えたりすることができる。

#inner2()は引数を要求せず、外側の関数に対する引数sを直接使う。 #knights2()はinner2を呼び出すのではなくその関数名を返す。 #inner2はクロージャとして機能している。 >>> def knights2(s): ... def inner2(): ... return "%s" % s ... return inner2 ... >>> a= knights2("Duck") >>> b= knights2("Hasenpfeffer") >>> type(a) <class 'function'> >>> type(b) <class 'function'> #これらは関数だが、クロージャでもある。 >>> a <function knights2.<locals>.inner2 at 0x1006d6ef0> >>> b <function knights2.<locals>.inner2 at 0x1006d60e0> #これらを呼び出すと二つのクロージャはknights2に自分たちが作られていたsの内容を覚えている。 >>> a() 'Duck' >>> b() 'Hasenpfeffer'4.7.10 無名関数:ラムダ関数

- ラムダ関数は一つの文で表現される無名関数。

- 小さな関数をいくつも作って名前を覚えておかなければならないような場面で効果的。

>>> def edit_story(words,func): ... for word in words: ... print(func(word)) ... >>> stairs = ["x","u","z","r"] >>> def enliven(word): ... return word.capitalize()+"!" ... #リストから一文字ずつ取り出し、enlivenで処理している。 >>> edit_story(stairs,enliven) X! U! Z! R! #enliven()関数はとても短いのでラムダに取り替える。 #このラムダは1個の引数 wordをとる。 #":"から末尾までの部分は全て関数定義である。 >>> edit_story(stairs,lambda word:word.capitalize()+"!") X! U! Z! R!4.8 ジェネレータ

- ジェネレータはPythonのシーケンスを作成するオブジェクトである。

- ジェネレータはイテレータのデータソースになることが多い。

#ジェネレータ関数は値をreturnの代わりにyield文で返す。 >>> def my_range(first=0,last=10,step=1): ... number=first ... while number < last: ... yield number ... number +=step ... #my_rangeは通常の関数である。 >>> my_range <function my_range at 0x1009364d0> >>> ranger=my_range(1,5) #ジェネレータオブジェクトを返す。 >>> ranger <generator object my_range at 0x100636ed0> #ジェネレータオブジェクトを対象としてforによる反復処理をすることができる。 >>> for x in ranger: ... print(x) ... 1 2 3 44.9 ※デコレータ

- デコレータは入力として関数を一つとり、別の関数を返す関数。

- 以下のものを使ってデコレータを作成する。

- argsと*kwargs

- 関数内関数

- 引数としての関数

関数に対するデコレータは複数持てる。関数に最も近いデコレータが先に実行され、次にその上のデコレータが実行される。

先日実行した際に①のようなエラーが出ていたため本日、再度実行し直したら②のようなエラーが出てきました。

①に関してはかなり悩みましたが、

最初にadd_intsの引数a,bを定義してから再度document_itを実行したところ通常に結果が返されたため引数a,bを指定していないからエラーが発生したのだと考えております。しかし、本には引数を指定せずとも実行結果が正しく出ているため本当に自分の考えが正しいか分かりません。(③のように引数指定するとエラーでない)②も不明のためご教示ください。

#① >>> def document_it(func): ... def new_function(*args,**kwargs): ... print("Running function:",func.__name__) ... print("Positional arguments:",args) ... print("Keyword arguments:",kwargs) ... result =func(*args,**kwargs) ... print("Result:",result) ... return result ... return new_function() ... >>> def add_ints(a,b): ... return a+b ... >>> add_ints(1,2) 3 >>> cooler_add_ints =document_it(add_ints) Running function: add_ints Positional arguments: () Keyword arguments: {} Traceback (most recent call last): File "<stdin>", line 1, in <module> File "<stdin>", line 9, in document_it File "<stdin>", line 6, in new_function TypeError: add_ints() missing 2 required positional arguments: 'a' and 'b'#②なぜかエラーが... #result定義されていると思うのだが。 >>> def document_it(func): ... def new_function(*args,**kwargs): ... print("Running function:",func.__name__) ... print("Positiona.:",func.__name__) ... print("Positional arguments:", args) ... print("Positional arguments:",func.__name__) ... print("Keyword arguments:", kwargs) ... print("Result:",result) ... return result ... return new_function() ... >>> def add_ints(a,b): ... return a+b ... >>> add_ints(3,5) 8 >>> c_add_ints=document_it(add_ints) Running function: add_ints Positiona.: add_ints Positional arguments: () Positional arguments: add_ints Keyword arguments: {} Traceback (most recent call last): File "<stdin>", line 1, in <module> File "<stdin>", line 10, in document_it File "<stdin>", line 8, in new_function NameError: name 'result' is not defined上記2点回答いただけるとありがたいです。

#③ >>> def document_it(func): ... def new_function(*args,**kwargs): ... print("Running function:",func.__name__) ... print("Positional arguments:",args) ... print("Keyword arguments:",kwargs) ... result =func(*args,**kwargs) ... print("Result:",result) ... return result ... return new_function() ... #デコレートしたい関数の直前に@decorator_name形式で追加する。 >>> @document_it ... def add_ints(a=1,b=2): ... return a+b ... Running function: add_ints Positional arguments: () Keyword arguments: {} Result: 34.10 名前空間とスコープ

- 名前空間とは特定の名前の意味が一意に決まり、他の名前空間と同じ名前とは無関係になる領域のこと。しかし、必要なら他の名前空間にアクセスできる。

- プログラムのメイン部分はグローバル名前空間を定義する。この名前空間の変数はグローバル変数と呼ばれる。

- pythonは名前空間にアクセスするために二つの関数を用意している。

- locals()はローカル名前空間の内容を示す辞書を返す。

- globals()はグローバル名前空間の内容を示す辞書を返す。

#グローバル変数の値は関数内から参照できる。 >>> animal="Z" >>> def print_global(): ... print("inside print_global:",animal) ... >>> print("at the top level:",animal) at the top level: Z >>> print_global() inside print_global: Z #関数内でグローバル変数の値を取得し、書き換えようとするとエラーが起きる。 >>> def changed_and_print_global(): ... print("inside change_and_print_global:",animal) ... animal="wombat" ... print("after the change:",animal) ... >>> changed_and_print_global() Traceback (most recent call last): File "<stdin>", line 1, in <module> File "<stdin>", line 2, in changed_and_print_global UnboundLocalError: local variable 'animal' referenced before assignment #change_local()関数もanimalという変数を持っているが、その変数は関数のローカル名前空間内の存在。 >>> animal="Z" >>> def change_local(): ... animal = "W" ... print("inside change_local:",animal,id(animal)) ... #change_local()の中のanimal変数がプログラム内のanimal変数とは別物であることがわかる。 >>> change_local() inside change_local: W 4564475440 >>> animal 'Z' >>> id(animal) 4564751344 #グローバル変数にアクセスするにはglobalキーワードを使ってそのことを明示しなければならない。 >>> animal="Z" >>> def change_and_print_global(): ... global animal ... animal = "wombat" ... print("inside change_and_print_global:",animal) ... >>> animal 'Z' >>> change_and_print_global() inside change_and_print_global: wombat >>> animal 'wombat' #関数内でglobalと書かなければ、Pythonはローカル名前空間を使い、animal変数はローカルになる。関数が終わったら、ローカル変数は消えて無くなる。 >>> animal="Z" >>> def change_local(): ... animal = "wombat" ... print("locals:",locals()) ... >>> animal 'Z' #ローカル名前空間の内容を示す辞書を返す。 >>> change_local() locals: {'animal': 'wombat'} #グローバル名前空間の内容を示す辞書を返す。 >>> print("globals:",globals()) globals: {'__name__': '__main__', '__doc__': None, '__package__': None, '__loader__': <class '_frozen_importlib.BuiltinImporter'>, '__spec__': None, '__annotations__': {}, '__builtins__': <module 'builtins' (built-in)>, 'document_it': <function document_it at 0x110146290>, 'add_ints': 3, 'square_it': <function square_it at 0x110146440>, 'animal': 'Z', 'print_global': <function print_global at 0x1101464d0>, 'changed_and_print_global': <function changed_and_print_global at 0x1101465f0>, 'change_local': <function change_local at 0x110146950>, 'change_and_print_global': <function change_and_print_global at 0x110146830>} >>> animal 'Z'4.10.1 名前の中のと_

- 先頭と末尾が2個のアンダースコアになっている名前は、Pythonが使う変数として予約されている。

>>> def amazing(): ... '''これは素晴らしい関数だ ... もう1度見る''' #関数の名前はシステム変数のfunction_name__(基本形式) ... print("この関数の名前:",amazing.__name__) #docstringはシステム変数のfunction_doc__(基本形式) ... print("docstring:",amazing.__doc__) ... >>> amazing() この関数の名前: amazing docstring: これは素晴らしい関数だ もう1度見る4.11 エラー処理とtry,except

- 例外が起きそうなところには全て例外処理を追加して、ユーザーに何が起きるか知らせておくのがグッドプラクティス。

#プログラム強制終了 >>> short_list=[1,2,3] >>> position = 5 >>> short_list[position] Traceback (most recent call last): File "<stdin>", line 1, in <module> IndexError: list index out of range #tryを使って例外が起きそうな場所を囲み、exceptを使って例外処理を提供すべき。 #tryブロックのコードが実行され、そこでエラーが起きると例外は生成されexceptブロックのコードが実行される。例外が起きなければexceptブロックは実行されない。 >>> short_list=[1,2,3] >>> position = 5 >>> try: ... short_list[position] ... except: ... print("Need a position between 0 and",len(short_list)-1,"but got",position) ... Need a position between 0 and 2 but got 5#exceptを使うと全ての例外をキャッチする。 #詳細情報が分かるようにしたい場合、except exceptiontype as nameの基本形式を記述する。 >>> short_list=[1,2,3] >>> while True: ... value=input("Position[q to quit]?") ... if value =="q": ... break ... try: ... position=int(value) ... print(short_list[position]) ... except IndexError as err: ... print("bad index:",position) ... except Exception as other: ... print("Something else broke:",other) ... Position[q to quit]?1 2 Position[q to quit]?0 1 Position[q to quit]?2 3 Position[q to quit]?3 bad index: 3 Position[q to quit]?2 3 Position[q to quit]?two Something else broke: invalid literal for int() with base 10: 'two' Position[q to quit]?q4.12 独自例外の作成

- 独自の例外型を定義できる。

#例外が生成された時に何を表示すべきか親クラスのExceptionに任せている。 >>> class OopsException(Exception): ... pass ... >>> try: ... raise OopsException("panic") ... except OopsException as exc: ... print(exc) ... panic4.13 復習課題

4-1 変数guess_meに7を代入しよう。次にguess_meが7より小さければtoo low、7よりも大きければtoo high、等しければjust right表示しよう。

>>> if guess_me<7: ... print("too low") ... elif guess_me>7: ... print("too high") ... elif guess_me==7: ... print("just right") ... just right4-2 変数guess_meに7、変数startに1を代入し、startとguess_meを比較するwhileループを書こう。

>>> while True: ... if start<guess_me: ... print("too low") ... elif start==guess_me: ... print("found it!") ... break ... elif start>guess_me: ... print("oops") ... break ... start+=1 ... too low too low too low too low too low too low found it!##4-3 forループを使ってリスト[3,2,1,0]の値を表示しよう。

>>> list=[3,2,1,0] >>> for x in list: ... print(list[x]) ... 0 1 2 34-4 リスト内包表記を使ってrange(10)の偶数のリストを作ろう。

>>> list=[number for number in range(10) if number%2==0] >>> list [0, 2, 4, 6, 8]4-5 辞書内包表記を使ってsquaresという辞書を作ろう。ただし、range(10)を使ってキーを返し、各キーの辞書の自乗をその値とする。

>>> squares={number:number*number for number in range(10)} >>> squares {0: 0, 1: 1, 2: 4, 3: 9, 4: 16, 5: 25, 6: 36, 7: 49, 8: 64, 9: 81}4-6 集合内包表記を使ってrange(10)の奇数からoddという集合を作ろう。

>>> odd= {number for number in range(10) if number%2==1} >>> odd {1, 3, 5, 7, 9}4-7 ジェネレータ内包表記を使ってrange(10)の数値に対しては"Got "と数値を返そう。

>>> for thing in ("Got %s" %number for number in range(10)): ... print(thing) ... Got 0 Got 1 Got 2 Got 3 Got 4 Got 5 Got 6 Got 7 Got 8 Got 94-8 ["H","R","Hermione"]というリストを返すgoodという関数を定義しよう。

>>> def good(): ... print(["H","R","Hermione"]) ... >>> good() ['H', 'R', 'Hermione']4-9 range(10)から奇数を返すget_oddsというジェネレータ関数を定義しよう。また、forループを使って、返された3番目の値を見つけて表示しよう。

#ジェネレータ関数はyieldで返す。 >>> def get_odds(): ... for x in range(1,10,2): ... yield x ... #enumerate()関数を使うと、for文の中でリスト(配列)などのイテラブルオブジェクトの要素と同時にインデックス番号(カウント、順番)を取得できる。インデックス番号, 要素の順に取得できる。 #オフセットを1からに指定。 >>> for count,number in enumerate(get_odds(),1): ... if count==3: ... print("The third number is",number) ... break ... The third number is 54-10 関数が呼び出された時に"start"、終了した時に"end"を表示するデコレータを定義しよう。

>>> def test(func): ... def new_func(*args,**kwargs): ... print("start") ... result = func(*args,**kwargs) ... print("end") ... return result ... return new_func ... >>> @test ... def greeting(): ... print("Hello!") ... >>> greeting() start Hello! end4-11 OopseExceptionという例外を定義しよう。次に何が起きたかを知らせるためにこの例外コードとこの例外をキャッチして"Caught an oops"と表示するコードを書こう。

#OopseExceptionの定義 >>> class OopseException(Exception): ... pass ... >>> raise OopseException() Traceback (most recent call last): File "<stdin>", line 1, in <module> __main__.OopseException >>> try: ... raise OopseException ... except OopseException: ... print("Caught an oops") ... Caught an oops4-12 zip()を使ってmoviesという辞書を作ろう。辞書はtitles=["C","B","A"]、plots=["D","W"]というリストを組み合わせて作るものとする。

>>> titles=["C","B","A"] >>> plots=["D","W"] >>> movies=dict(zip(titles,plots)) >>> movies {'C': 'D', 'B': 'W'}感想

4.9 デコレータが不明だったのでご教示いただければと思います。

よろしくお願いいたします。

4章の復習ボリューム多かったな。1日がかりだった。参考文献

「Bill Lubanovic著 『入門 Python3』(オライリージャパン発行)」

- 投稿日:2020-01-13T23:42:16+09:00

PythonGUI(コンボックス)で行列を作成

GUI(コンボボックス)で行列の要素の値を入力し2次元配列型のデータを取得するソースです。行列のサイズ、コンボボックスのリストも変数により変更可能。

qiita.rbfrom tkinter import * from tkinter import ttk import numpy as np #入力用のGUI def GUI_Input(n,m): root = Tk() root.title('Table Input') #入力用フレーム frame = ttk.Frame(root) frame.grid(row=0, column=0) list_Items = [0]*(n*m) N = n M = m k=0 for i in range(0, n): for j in range(0, m): valuelist = [1,2,3,4,5,6,7,8,9] list_Items[k] = ttk.Combobox(frame,values=valuelist,width = 2) list_Items[k].grid(row=i+1, column=j+1) k+=1 #コンボボックスからデータを取得し2次元配列としてpritnt出力 def ButtonClicked_Run(): B = [0]*(N*M) for i in range(N*M): B[i] = list_Items[i].get() A= np.reshape(B, (N,M)) print(A) #実行ボタンの設置 button_Run = ttk.Button(root, text='実行', padding=5, command=ButtonClicked_Run) button_Run.grid(row=1, column=0) root.mainloop() #n、mの数を変えて、行列のサイズを指定 m = 9 n = 9 GUI_Input(m,n)

- 投稿日:2020-01-13T23:42:16+09:00

PythonGUI(コンボボックス)で行列を作成

GUI(コンボボックス)で行列の要素の値を入力し2次元配列型のデータを取得するソースです。行列のサイズ、コンボボックスのリストも変数により変更可能。

qiita.rbfrom tkinter import * from tkinter import ttk import numpy as np #入力用のGUI def GUI_Input(n,m): root = Tk() root.title('Table Input') #入力用フレーム frame = ttk.Frame(root) frame.grid(row=0, column=0) list_Items = [0]*(n*m) N = n M = m k=0 for i in range(0, n): for j in range(0, m): valuelist = [1,2,3,4,5,6,7,8,9] list_Items[k] = ttk.Combobox(frame,values=valuelist,width = 2) list_Items[k].grid(row=i+1, column=j+1) k+=1 #コンボボックスからデータを取得し2次元配列としてpritnt出力 def ButtonClicked_Run(): B = [0]*(N*M) for i in range(N*M): B[i] = list_Items[i].get() A= np.reshape(B, (N,M)) print(A) #実行ボタンの設置 button_Run = ttk.Button(root, text='実行', padding=5, command=ButtonClicked_Run) button_Run.grid(row=1, column=0) root.mainloop() #n、mの数を変えて、行列のサイズを指定 m = 9 n = 9 GUI_Input(m,n)

- 投稿日:2020-01-13T23:42:16+09:00

PythonGUI(tkinterコンボボックス)で行列を作成

GUI(tkinterコンボボックス)で行列の要素の値を入力し2次元配列型のデータを取得するソースです。行列のサイズ、コンボボックスのリストも変数により変更可能。

qiita.rbfrom tkinter import * from tkinter import ttk import numpy as np #入力用のGUI def GUI_Input(n,m): root = Tk() root.title('Table Input') #入力用フレーム frame = ttk.Frame(root) frame.grid(row=0, column=0) list_Items = [0]*(n*m) N = n M = m k=0 for i in range(0, n): for j in range(0, m): valuelist = [1,2,3,4,5,6,7,8,9] list_Items[k] = ttk.Combobox(frame,values=valuelist,width = 2) list_Items[k].grid(row=i+1, column=j+1) k+=1 #コンボボックスからデータを取得し2次元配列としてpritnt出力 def ButtonClicked_Run(): B = [0]*(N*M) for i in range(N*M): B[i] = list_Items[i].get() A= np.reshape(B, (N,M)) print(A) #実行ボタンの設置 button_Run = ttk.Button(root, text='実行', padding=5, command=ButtonClicked_Run) button_Run.grid(row=1, column=0) root.mainloop() #n、mの数を変えて、行列のサイズを指定 m = 9 n = 9 GUI_Input(m,n)

- 投稿日:2020-01-13T23:16:19+09:00

【Python】 jsonと辞書

はじめに

Pythonでjsonのデータを扱うことがあったのですが、Python標準のdict型と親和性があるので紹介します。

jsonとは

こちらとても参考になります。ありがとうございます。

JavaScript Object Notation

データを表現するための記法です。

JavaScriptの構文に似ていますが、JavaScriptとは独立して扱われます。

JavaScript以外のプログラミング言語でもJSONを扱うことができる機能が準備されています。この記事はJSONを使っていくことを中心な記事なので細かい説明は省略します。

形式は以下のようなものです。keyに対してvalueが紐づいているという感じです。{ "key":value, "key":value, "key":value }keyとvalueのセットというのはPythonのdictと同じですね。

Pythonのjsonモジュール

Pythonにjsonモジュールが存在します。dict⇔jsonの変換を主にやってくれます。

dictからjsonへの変換には

json.dumpsを使います。

dictの型はもちろんdictですが、変換後はstr型になります。import json sample_dict = {"Japan":"Tokyo","UK":"London","USA":"Washington, D.C."} print(type(sample_dict)) print(sample_dict) # 出力 # <class 'dict'> # {'Japan': 'Tokyo', 'UK': 'London', 'USA': 'Washington, D.C.'} # 変換 sample_json = json.dumps(sample_dict) print(type(sample_json)) print(sample_json) # 出力 # <class 'str'> # {"Japan": "Tokyo", "UK": "London", "USA": "Washington, D.C."}pandasからjsonに変換する

pandas DataFrameやpandas Seriesからもjsonに変換することができます。個人的にpandasはよく使うのでありがたいです。

pandasDataFrame(Series)からjsonへの変換はto_json()を使います。import pandas as pd df_sample = pd.DataFrame([[1,1,1],[2,3,4],[8,7,6]],columns=["x","y","z"],index=["A","B","C"]) json_df = df_sample.to_json() print(df_sample) print(json_df) # 出力 x y z A 1 1 1 B 2 3 4 C 8 7 6 {"x":{"A":1,"B":2,"C":8},"y":{"A":1,"B":3,"C":7},"z":{"A":1,"B":4,"C":6}}jsonを読み込む

jsonのデータを読み込むには json.loads を使います。

先ほどのsample_jsonを使います。dict_json = json.loads(sample_json) print(type(dict_json)) print(dict_json) # 出力 # <class 'dict'> # {'Japan': 'Tokyo', 'UK': 'London', 'USA': 'Washington, D.C.'}もちろんdict_jsonはPythonのdictなので

print(dict_json['Japan']) # 出力 # Tokyoこのような形でアクセスできます。

おわりに

jsonはpythonだけでなくほかの言語でも使えるので言語間の通信に便利です。ここでは最低限しか説明してませんがぜひ使ってみてください!

思ったこと

自分が使ってみて、とかの視点で書いているのでまったく網羅的に触れることができていない記事ばかりだなと思いました。とりあえず今後も自分が使ってみたものについて書いてみて、見直す必要があった場合は記事を更新していこうかなと思います。

- 投稿日:2020-01-13T23:16:19+09:00

【Python】 PythonでJSONを使う

はじめに

Pythonでjsonのデータを扱うことがあったのですが、Python標準のdict型と親和性があるので紹介します。

jsonとは

こちらとても参考になります。ありがとうございます。

JavaScript Object Notation

データを表現するための記法です。

JavaScriptの構文に似ていますが、JavaScriptとは独立して扱われます。

JavaScript以外のプログラミング言語でもJSONを扱うことができる機能が準備されています。この記事はJSONを使っていくことを中心な記事なので細かい説明は省略します。

形式は以下のようなものです。keyに対してvalueが紐づいているという感じです。{ "key":value, "key":value, "key":value }keyとvalueのセットというのはPythonのdictと同じですね。

Pythonのjsonモジュール

Pythonにjsonモジュールが存在します。dict⇔jsonの変換を主にやってくれます。

dictからjsonへの変換には

json.dumpsを使います。

dictの型はもちろんdictですが、変換後はstr型になります。import json sample_dict = {"Japan":"Tokyo","UK":"London","USA":"Washington, D.C."} print(type(sample_dict)) print(sample_dict) # 出力 # <class 'dict'> # {'Japan': 'Tokyo', 'UK': 'London', 'USA': 'Washington, D.C.'} # 変換 sample_json = json.dumps(sample_dict) print(type(sample_json)) print(sample_json) # 出力 # <class 'str'> # {"Japan": "Tokyo", "UK": "London", "USA": "Washington, D.C."}pandasからjsonに変換する

pandas DataFrameやpandas Seriesからもjsonに変換することができます。個人的にpandasはよく使うのでありがたいです。

pandasDataFrame(Series)からjsonへの変換はto_json()を使います。import pandas as pd df_sample = pd.DataFrame([[1,1,1],[2,3,4],[8,7,6]],columns=["x","y","z"],index=["A","B","C"]) json_df = df_sample.to_json() print(df_sample) print(json_df) # 出力 x y z A 1 1 1 B 2 3 4 C 8 7 6 {"x":{"A":1,"B":2,"C":8},"y":{"A":1,"B":3,"C":7},"z":{"A":1,"B":4,"C":6}}jsonを読み込む

jsonのデータを読み込むには json.loads を使います。

先ほどのsample_jsonを使います。dict_json = json.loads(sample_json) print(type(dict_json)) print(dict_json) # 出力 # <class 'dict'> # {'Japan': 'Tokyo', 'UK': 'London', 'USA': 'Washington, D.C.'}もちろんdict_jsonはPythonのdictなので

print(dict_json['Japan']) # 出力 # Tokyoこのような形でアクセスできます。

おわりに

jsonはpythonだけでなくほかの言語でも使えるので言語間の通信に便利です。ここでは最低限しか説明してませんがぜひ使ってみてください!

思ったこと

自分が使ってみて、とかの視点で書いているのでまったく網羅的に触れることができていない記事ばかりだなと思いました。とりあえず今後も自分が使ってみたものについて書いてみて、見直す必要があった場合は記事を更新していこうかなと思います。

- 投稿日:2020-01-13T22:48:54+09:00

Pythonのパの字も知らない人間がTensorFlowチュートリアルやりながら"完全に理解"していった記録

まえがき

こんにちは、 Webエンジニアをやっているますみんと申します。機械学習が巷では流行りに流行っていますね。自分も大学の講義でなんとなーくやった記憶があるのですが、もう既に覚えてません。さすがにチュートリアルくらいやっておかないと流行についていけないだろうという若干後ろめたい気持ちがドリブンにドリブンを重ねたので、今回はTensorFlowのニューラルネットワークのチュートリアルをやってみることにします。

注意

この記事は、Pythonを触ったこともない初心者がドキュメントあさりながらあーだこーだやった記録です。やったこと、思ったことをそのまま書いていますので、読みやすさは保証できかねます。

環境構築

何から手を付けたらいいのかすらよく分からないけれど、自分の中ではとりあえず「機械学習といえばPython + TensorFlow」っていうイメージなので、TensorFlowをインストールします。TensorFlowってGoogleが作ってるんですね。初めて知りました。

Pythonバージョン確認

Pythonコマンド打ってみる$ python Python 2.7.16 (default, Apr 12 2019, 15:32:40)Pythonは2.x系と3.x系で全然別モノだから気をつけろって誰かに言われた気もしますが、まだ触ったこともないのでそんなのは知りません。とりあえず既にMacに入っていた2.x系で進めることにします。

pipのアップデート

参考: 公式ドキュメント "Install TensorFlow 2"

公式ドキュメントのインストール手順に従い、インストールを進めていきます。GitHubによると、2020/01/12時点でのTensorFlowの最新Versionは2.1.0のようです。

Pythonではpip(Pip Installs Packages)というパッケージ管理ツールで各種パッケージをインストールできるようですね。TensorFlowもこのpipを使ってインストールします。ちなみにちなむと、pipはRubyでいうところのGem、PHPでいうところのComposerみたいなやつです。まずはpip自体のアップデートをします。

pipのアップデート$ pip install -U pip DEPRECATION: Python 2.7 will reach the end of its life on January 1st, 2020. Please upgrade your Python as Python 2.7 won't be maintained after that date. A future version of pip will drop support for Python 2.7. Collecting pip Downloading https://files.pythonhosted.org/packages/00/b6/9cfa56b4081ad13874b0c6f96af8ce16cfbc1cb06bedf8e9164ce5551ec1/pip-19.3.1-py2.py3-none-any.whl (1.4MB) 100% |████████████████████████████████| 1.4MB 7.8MB/s Installing collected packages: pip Found existing installation: pip 19.0.3 Uninstalling pip-19.0.3: Successfully uninstalled pip-19.0.3 Successfully installed pip-19.3.1いきなり悲しいメッセージが表示されました。なんと2020年1月1日でPython2.7はその生涯に幕を下ろしたとのこと?pipも今後のバージョンアップでPython2.7のサポートを終了すると書いてありますね...。Macにはいっているのはガッツリ2.7系のPythonなので、これは困りました...。

それじゃあせっかくなのでTensorFlowがサポートしている中で最新のPythonをインストールしましょう。

2020/01/12時点でPython自体の最新版はVer. 3.9.0a2ですが、TensorFlowでは3.4〜3.7系をサポートしているようなので、3.7.x系で最新の安定版であるVer. 3.7.6をインストールすることにします。Python 3.7.6のインストール

pyenvのインストール

公式ドキュメントに従って直接Pythonをインストールしてもよいのですが、後々またバージョンの違いに泣かされるのは嫌なので、Pythonのバージョン管理ツールを使ってインストールすることにします。

ツールはいろいろあるみたいですが、自分の周りでも結構触ってる人が多いのでpyenvを使うことにしました。pyenvのREADME曰く、MacならHomebrewでインストールできるようですね。ではさっそくインストールしましょう?

pyenvのインストール$ brew update $ brew install pyenvpyenvがインストール出来たか確認$ pyenv pyenv 1.2.16 ...pyenv 1.2.16が無事インストールされました!

pyenvでPython 3.7.6をインストール

インストールしといてアレなんですが、そもそもpyenvでインストールできるバージョンの中に本当にVer. 3.7.6が含まれているのかが分かりません。インストールできるバージョンを確認してみます。

まずはinstallコマンド自体のヘルプを確認してみます。pyenv installコマンドのヘルプを確認$ pyenv install -h Usage: pyenv install [-f] [-kvp] <version> pyenv install [-f] [-kvp] <definition-file> pyenv install -l|--list pyenv install --version -l/--list List all available versions -f/--force Install even if the version appears to be installed already -s/--skip-existing Skip if the version appears to be installed already python-build options: -k/--keep Keep source tree in $PYENV_BUILD_ROOT after installation (defaults to $PYENV_ROOT/sources) -p/--patch Apply a patch from stdin before building -v/--verbose Verbose mode: print compilation status to stdout --version Show version of python-build -g/--debug Build a debug version For detailed information on installing Python versions with python-build, including a list of environment variables for adjusting compilation, see: https://github.com/pyenv/pyenv#readmeどうやら

pyenv install -lもしくはpyenv install --listでインストールできるバージョン一覧を表示できるようです。

ではこのコマンドを打って、 Ver. 3.7.6がインストールできるか確認してみましょう。pyenvでインストール可能なPythonのバージョン一覧表示$ pyenv install -l Available versions: 2.1.3 2.2.3 ... 3.7.6 ...おお、ちゃんとインストールできるみたいですね!一安心です。では改めて、pyenvでVer. 3.7.6をインストールしましょう。

Python 3.7.6をインストール$ pyenv install 3.7.6 python-build: use openssl@1.1 from homebrew python-build: use readline from homebrew Downloading Python-3.7.6.tar.xz... -> https://www.python.org/ftp/python/3.7.6/Python-3.7.6.tar.xz Installing Python-3.7.6... python-build: use readline from homebrew python-build: use zlib from xcode sdk Installed Python-3.7.6 to /Users/<ユーザー名>/.pyenv/versions/3.7.6インストールが終わったようです。でもインストールしただけではまだバージョンが切り替わっていません。

Pythonのバージョン確認$ python --version Python 2.7.16pyenvで使用するPythonのバージョンを指定

もう2.7系は使わないので、pyenvにてMac全体で使用するPythonのバージョンを3.7.6に指定してしまいましょう。

pyenvでglobalバージョンを3.7.6に指定$ pyenv global 3.7.6指定をしたので、再度シェルからPythonのバージョンを確認してみます。

Pythonのバージョン確認$ python --version Python 2.7.16おや、バージョンが切り替わっていません。よくあるパスの問題ですね。

pyenvでインストールしたPythonにパスが通っておらず、pythonコマンドで使える状態になっていません。pyenvでインストールしたPythonのありかにパスを通す

パスを通しましょう。自分はMacのshellをbashのままにしている(macOS Catalinaからはzshがデフォルトになっている)ので、bash_profileに以下を追記します。

~/.bash_profileに追記export PYENV_ROOT="$HOME/.pyenv" # /Users/<ユーザー名>/.pyenv export PATH="$PYENV_ROOT/bin:$PATH" # パス一覧に最優先で $PYENV_ROOT/bin を追加(パスは左側が優先される) eval "$(pyenv init -)" # $PYENV_ROOT/shimsディレクトリ追加、指定したバージョンのPythonをshimsにコピーする。終わったら$PYENV_ROOT/shimsを$PATHに追加追記が終わったら

sourceコマンドで設定を反映させます。~/.bash_profileに記述した設定を反映$ source ~/.bash_profile設定を反映したので、シェルからpythonコマンドのパスを確認してみます。

pythonコマンドのパス確認$ which python /Users/<ユーザー名>/.pyenv/shims/pythonpyenvでインストールしたPythonの方に向いていますね!これでOKです。再度グローバルのバージョンを設定し、バージョンを確認してみます。

グローバルのPythonバージョン設定と確認$ pyenv global 3.7.6 $ python --version Python 3.7.6ちゃんとバージョンが切り替わってますね!これでようやくTensorFlowのインストールに戻れます!

ちょっと脱線「パスって何?」

「パスって何?」っていう人は、「コマンド名を打った時に実際に実行されるファイルのありか」って覚えておけばOKです。

今回はpythonって打った時にpyenvでインストールしたPythonを使いたかったのですが、実際に実行されるファイルのありかにpyenvでインストールしたPythonのありかが入っていなかったので使えなかった、ということになります。もちろん実行ファイル自体は存在していますので、実行ファイルを直指定すれば使うことができます。pyenvでインストールしたPythonの実行ファイルを直指定してバージョン確認$ ~/.pyenv/versions/3.7.6/bin/python --version Python 3.7.6pipのアップデート

pipもpyenv配下のものを使うように変わったので、改めてアップデートをしておきます。

pipコマンドの実態のありかがpyenv配下になっている$ pip --version pip 19.2.3 from /Users/<ユーザー名>/.pyenv/versions/3.7.6/lib/python3.7/site-packages/pip (python 3.7)pipのアップデート$ pip install -U pip Collecting pip Using cached https://files.pythonhosted.org/packages/00/b6/9cfa56b4081ad13874b0c6f96af8ce16cfbc1cb06bedf8e9164ce5551ec1/pip-19.3.1-py2.py3-none-any.whl Installing collected packages: pip Found existing installation: pip 19.2.3 Uninstalling pip-19.2.3: Successfully uninstalled pip-19.2.3 Successfully installed pip-19.3.1アップデートが完了しました!

TensorFlowをインストール

だいぶ遠回りをしてしまいましたが、ようやく諸問題が片付きました。ではpipでTensorFlowをインストールしてみましょう。

TensorFlowの公式ドキュメント曰く、

- 最新の安定版をインストールする場合 ...

pip install tensorflow- 最新の開発版をインストールする場合 ...

pip install tf−nightlyとするようです。最新の安定版をインストールしたいので、今回は前者のコマンドになります。

TensorFlowをインストール$ pip install tensorflowインストールが完了しました!いい感じ!!

Pythonスクリプトを実行してみる

全くの初心者なので、そもそもPythonをどうやって動かすのかよく分かっていません。なのでまず最初にHello Worldしてみたいと思います。

試しにHello, Worldとだけ表示するスクリプトを書いてみます。Pythonでは変数の標準出力はprint()関数で行えるようです。sample.pyprint('Hello, World')このPythonスクリプトをコマンドラインから実行してみます。

sample.pyを実行$ python sample.py Hello, Worldおおっ、Hello Worldができました!調子いいですね?

ちなみにpythonとだけ打つと、対話型のPython実行環境が立ち上がります。いちいちスクリプト書いて実行するの面倒ならこちらでもいいかもしれません。TensorFlowのチュートリアルをやってみる

TensorFlow 公式ドキュメント "はじめてのニューラルネットワーク:分類問題の初歩"

さ、ようやく本題のTensorFlowのチュートリアルです?

初心者向けチュートリアルの中に「身につけるモノの写真分類」といういかにもそれっぽいお題があったので、今回はそれをやってみることにします。ちなみにこのチュートリアルで取り上げられている機械学習の手法はニューラルネットワークといって、生物の神経回路に似せた構造になっています。tutorial.pyfrom __future__ import absolute_import, division, print_function, unicode_literals # TensorFlow と tf.keras のインポート import tensorflow as tf from tensorflow import keras # ヘルパーライブラリのインポート import numpy as np import matplotlib.pyplot as plt print(tf.__version__)ふむふむ。はじめにPythonのインポートシステムというのを使って他のモジュールを使えるようにしているのですね。fromはモジュールの中の特定属性だけimportするときに使う構文のようです。

__future__というモジュールが提供しているいろいろな機能を使えるようにしているわけですね。で次に、pipでさっきインストールしたtensorflowをインポートするわけですが、名前が長いから

tfという名前でモジュールを扱えるようにしてある、と。なるほど。このへんはJavaScriptとかでも見るやつですね。PHPもuse asで名前空間のエイリアス作成できますね。おんなじや!次の行をみると、tensorflowの中にkerasという機能が盛り込まれているようですね。これもそのままインポートすると

tf.kerasってなるはずですが、頻繁に使われるからkerasだけで呼べるようにしてある、ということですかね。ふむ〜。あとは同じですね。

numpyをnpで呼べるようにした上でインポート、matplotlib.pyplotをpltで呼べるようにした上でインポートしています。な〜んだ、初期化だけじゃんか!

そして最後にtf.__version__で、インストールしたTensorFlowのバージョンを表示して終了です。楽勝楽勝!?では一旦これで実行してみましょう。

tutorial.pyの実行$ python tutorial.py Traceback (most recent call last): File "tutorial.py", line 9, in <module> import matplotlib.pyplot as plt ModuleNotFoundError: No module named 'matplotlib'お、楽勝かと思っていたらさっそくエラー。コピペでうまく動かない箇所が出てきました。

matplotlibというパッケージがインストールされていないようですね。どうやらこのmatplotlibというパッケージは標準パッケージではないので、pipでのインストールが必要だったみたいです。

numpyも標準パッケージではないようですが、こちらはPythonのインストールの仕方によっては同梱されてるらしいです。以前ちらっとだけPython触ったときにもしかすると入っちゃったのかな?(無知)matplotlibパッケージをインストール

pipでmatplotlibパッケージをインストール$ pip install matplotlib無事にインストールが完了したら、再度tutorial.pyを実行します。

tutorial.pyの実行$ python tutorial.py 2.1.0今度はうまくいきました!バージョン2.1.0のTensorFlowがインストールされていることを確認できました!

ファッションMNISTデータセットのダウンロード

機械学習には、学習するためのデータセットが必要です。チュートリアルで使用するデータセットをダウンロードする行をスクリプトに追加しましょう。追記した行だけ表示すると、以下のようになります。

tutorial.pyfashion_mnist = keras.datasets.fashion_mnist (train_images, train_labels), (test_images, test_labels) = fashion_mnist.load_data()kerasっていうのはPythonで使えるニューラルネットワークライブラリのことらしく、TensorFlowにも組み込まれています。読み方は「ケラス」っぽいです(公式ドキュメントで名前に触れている部分と、ギリシャ語表記の方のGoogle翻訳結果)。TensorFlowでは、よく使われるデータセットはこのtf.keras.datasets モジュールのAPIで呼び出せるようです。

ってか公式のドキュメント見てて思ったんですが、TensorFlow公式も自身のこと

tfって略して表記するの推奨なんですね。まぁ確かに、何回もコード内に出てきたらちょっと見づらいかもです?まま、さっそくダウンロードをば。

ファッションMNISTデータセットのダウンロード$ python tutorial.py 2.1.0 Downloading data from https://storage.googleapis.com/tensorflow/tf-keras-datasets/train-labels-idx1-ubyte.gz 32768/29515 [=================================] - 0s 0us/step Downloading data from https://storage.googleapis.com/tensorflow/tf-keras-datasets/train-images-idx3-ubyte.gz 26427392/26421880 [==============================] - 2s 0us/step Downloading data from https://storage.googleapis.com/tensorflow/tf-keras-datasets/t10k-labels-idx1-ubyte.gz 8192/5148 [===============================================] - 0s 1us/step Downloading data from https://storage.googleapis.com/tensorflow/tf-keras-datasets/t10k-images-idx3-ubyte.gz 4423680/4422102 [==============================] - 0s 0us/stepダウンロードが完了しました!一度ダウンロードしてしまったあとは、もうダウンロードの必要はないみたいですね。

ちなみにダウンロードしてきたファイルは~/.keras/datasets/<データセット名>/に保存されます。keras APIのドキュメントを見ると保存先のパスを渡せるみたいなので、TensorFlowで用意されたラッパーではなく元のAPIを使えば任意の場所に保存できます。データセットの保存先$ ls ~/.keras/datasets/fashion-mnist/ t10k-images-idx3-ubyte.gz t10k-labels-idx1-ubyte.gz train-images-idx3-ubyte.gz train-labels-idx1-ubyte.gzちょっと脱線「MNISTデータセット(MNIST Database)って何?」

機械学習では、大量のデータ群を学習させることでモデルを作り出します。この大量のデータ群というのがミソで、数十というオーダーではまず足りません。さらに集めたデータ群は入力のフォーマットが揃うように前処理が必要となるため、データ集めだけで骨が折れるというのがこの分野でよく言われること(らしい)です。これでは初心者の参入障壁が爆上がりしてしまう(学習させられるだけのデータ群を用意できずに挫折する)ということで、初学者向けのチュートリアル等では予め用意されたデータセットを使うことが多いようです。

機械学習界隈で有名なデータセットの1つにNIST Databaseがあります。これはもともとアメリカ国立標準技術研究所(NIST)のSRD(Standard Reference Data)で頒布されていた手書き文字のデータ群であり、このNIST Databaseをより使いやすく改修したのがMNIST Database(MNISTのMはModifiedのM)です。MNIST Databaseは機械学習のいわばHello Worldといえます。TensorFlowのtf.keras.datasetsモジュールでももちろんMNIST Databaseが使えます。

TensorFlowのチュートリアルでは、単純かつ使われすぎてしまったMNISTデータセットを置き換える目的で作られたファッションMNISTデータセットを使用しています。学習データの用意

機械学習の大枠の流れとしては、

- モデルを作成

- 学習データをモデルに流し、学習させる

- 学習が済んだモデルにテストデータを流し、精度を確認する

- 学習が済んだモデルに実データを流す

という感じです。ただモデルを作っただけではダメで、分類やらなんやらのコツを学習するための学習データ、モデルの精度を確認するためのテストデータが必要ということですね。ファッションMNISTデータセットには、学習データとテストデータの両方が含まれています。試しに以下を

tutorial.pyに追記して、学習データの1番目を表示してみます。tutorial.py(学習データを表示する)plt.figure() plt.imshow(train_images[0]) plt.colorbar() plt.grid(False) plt.show()

pltはimport matplotlib.pyplot as pltでインポートした機能でした。matplotlibはおそらくmatrix plot libraryの略称かと思われますが、要は行列に格納されたデータからいい感じの図を作ってくれるモジュールです。このモジュールのうち、pyplotっていう機能を使うやで〜ってことですね。公式曰くpyplotはMATLABライクなインターフェースで図を描くことができるとのことで、用意された関数やその使い方は確かにMATLABっぽさがある...かも。

新しい図を作成して、図に画像を貼り付けてカラーバー表示して、グリッド消して図を表示する。MATLABのimagesc()とかそのへんに近いですね。じゃあスクリプトを実行して学習データの1番目を表示してみましょう。これは...ブーツですね!こんな感じで、0〜255の値が入った28px × 28pxの画像が60,000枚入っています。じゃあこれをさっそくニューラルネットワークに...といきたいところですが、それぞれの画素の値を0〜1の値にしてから突っ込みたいのでここでちょっとデータを加工。いわゆる前処理というやつですね。なるほど。

tutorial.py(データの前処理)train_images = train_images / 255.0 test_images = test_images / 255.0なにげな〜く書いていますが、配列の各要素を一気に割り算できるあたり、やはりPythonだな〜って感じがします。PHPとかRubyとかだとfor文で要素を1つずつ割っていかないといけないですからね。Pythonだと行列計算しやすいっていうのはこういう実装がされているからなんだな〜としみじみ感じます。

さて、各データセットには「その画像が実際何の画像なのか」を表す

ラベルが付いています。しかしラベルは文字列ではなく整数で格納されているので、クラス(それぞれの振る舞いを表すもの)の名称に衣料品の名前を付け、クラスとラベルとを対応付けます。tutorial.py(クラス名定義)class_names = ['T-shirt/top', 'Trouser', 'Pullover', 'Dress', 'Coat', 'Sandal', 'Shirt', 'Sneaker', 'Bag', 'Ankle boot']例えば

class_names[0]はT-shirt/top、class_names[1]はTrouser(ズボンのこと)といった具合になります。念の為、正しいクラス名になっているかどうかを確認しましょう。

tutorial.py(クラス名の確認)plt.figure(figsize=(10,10)) for i in range(25): plt.subplot(5,5,i+1) plt.xticks([]) plt.yticks([]) plt.grid(False) plt.imshow(train_images[i], cmap=plt.cm.binary) plt.xlabel(class_names[train_labels[i]]) plt.show()おお、チュートリアルページに載っているのと同じですね!(当たり前)

正しいラベルが振られていることが確認できました。後はモデルを作ってデータをブチ込むだけです!?コードをちょっと追ってみます。といってもほぼ「matplotlib.pyplotのドキュメント読め」で終わる話ではあるんですが?

figsizeはインチ指定です。この場合10インチ * 10インチの図を作るってことですね。ドキュメントによると、デフォルトは6.4インチ * 4.8インチです。

range()関数(正確には、作成後値が変更できない(イミュータブルという)Pythonの型)は、引数1こ(nとする)だけ取った場合n未満を常に満たすようにして、0から1ずつカウントアップしたものを返します。先述の通りrangeは型扱いなので、配列とはちょっと違うみたいですね。といってもインデックス指定して要素取ってくる操作は配列のそれと何ら変わりありませんが。for文まで来ました。Pythonのfor文は結構独特な書き方するんですね?他の言語のcase文っぽさがあります。Pythonにおいてインデントは非常に重要らしく、for文でインデントがないとエラーになってしまいます。まぁRubyとかと違ってendとかないし、そりゃそうだよねって感じです。

で画像を1枚1枚図に貼り付けていきます。5行5列の配置場所に対し、左上から始まり右端へ向けて画像を貼っていき、右端にきたら次の行に進む、という感じですね。plot()関数は1つの画像やグラフ表示、subplot()関数は複数の画像やグラフを表示するときに使うようですね。

xticks()、yticks()はそれぞれグラフの縦軸の目盛り、横軸の目盛りの刻みを取得 or 設定します。空の配列を渡すことで目盛りなしに出来ます。今回は画像を貼るので目盛りはいらないですね。なので空配列を渡しています。グリッド表示もいらないので、grid()にはFalseを渡しています。Pythonのbool型って頭文字が大文字なんですね。小文字でも判定できるようにするモジュールも用意されているようですが、使う時明示しないといけないのでちと面倒ですね。なんでこういう実装なんだろう。

imshow()はさっきやったので、xlabel()を見てみましょう。ってかgrid()もさっきあったな。まぁいいや。

xlabel()はx軸方向(今は横方向)に表示するラベルです。画像が属するクラスの名前を表示していますね。これをylabel()に変えると、y軸方向にラベルが表示されます。参考までに、4行7列で画像を表示してy軸方向にラベルをつけるとこんな具合になります。

だんだんわかってきたぞ!?

モデルを構築する

ここからは主にkeras APIを使うことになるので、説明はしょった部分はAPIのドキュメントみて補完してください。

いよいよモデルの構築に入ります。このチュートリアルではニューラルネットワークを構築しているといいましたが、ニューラルネットワークにおいて重要なのが

層と呼ばれる概念です。入力があったらなにかしら重み付けをして出力するものだと思ってもらえればいいかと。この層を順に積んで作るモデルを、kerasではSequentialと呼んでいるようですね。tutorial.py(モデル構築)model = keras.Sequential([ keras.layers.Flatten(input_shape=(28, 28)), keras.layers.Dense(128, activation='relu'), keras.layers.Dense(10, activation='softmax') ])モデルの中身がそれぞれ何をしているかはチュートリアルのページを是非見てほしい(逃げの姿勢!)のですが、平たく言うと

- 入力された画像(要素数28 * 28の2次元配列)を、1次元配列に変換(厳密にはこの層はニューラルネットワークの前処理をする層)

- 128個の人工ニューロンからなる全結合層を作り、ReLUという種類の伝達関数(活性化関数)に入力し値を加工、出力する

- 10個の人工ニューロンからなる全結合層を作り、ソフトマックスという種類の伝達関数(活性化関数)に入力し値を加工、出力する(出力は各ラベルに属する確率になる)

って感じです。まぁなんとなく分かったところで、モデルをコンパイルしてみましょう。

tutorial.py(モデルのコンパイル指示)model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])ここもなんとなく理解する程度にとどめておきます(ホントはこのあたりが一番面白いところだけど、ガッツリ数学なので)。ざっくり見ると、コンパイルには以下の3つが必要だということらしいですね。

- 損失関数(loss function) ... 誤差関数とも呼ばれるやつ。学習中のモデルの正確さを表す。値が低いほど正確。今回はsparse_categorical_crossentropyというやつを使う

- オプティマイザ(optimizer) ... モデルの更新方法。今回はAdamというアルゴリズムを用いている。

- メトリクス(metrics) ... モデルの更新ステップで何を監視するかを指定。今回はモデルの正解率を監視する

なんのこっちゃって感じになってきましたね。でも「機械学習を使ってとりあえず何かする」だけなら、この辺はあまり深く追わなくてOKです。何層で何をして、どういう更新方法使って...とかいう部分は全て、正解率を上げるための変数の1つに過ぎません。より正解率の高いモデルを作りたくなったら、その時初めて数学を学べばよいでしょう。ということで、今はこの辺スルーでいきます?

モデルに学習させる

学習用のデータセットをモデルに読み込ませて、学習をさせます。ニューラルネットワークに大量の画像を突っ込み、「この画像はこのクラスに分類されるやで〜?」っていうのを覚えさせるわけですね。かんたんかんたん!やってみましょう。

tutorial.py(モデルに学習させる)model.fit(train_images, train_labels, epochs=5)学習用のデータセットとラベルを使って、同じデータで5回学習させるわけですね。ふむふむ。いざ実行!

学習を実行する$ python tutorial.py 2020-01-12 23:53:12.524687: I tensorflow/core/platform/cpu_feature_guard.cc:142] Your CPU supports instructions that this TensorFlow binary was not compiled to use: AVX2 FMA 2020-01-12 23:53:12.684666: I tensorflow/compiler/xla/service/service.cc:168] XLA service 0x7ff1c0a736e0 initialized for platform Host (this does not guarantee that XLA will be used). Devices: 2020-01-12 23:53:12.684725: I tensorflow/compiler/xla/service/service.cc:176] StreamExecutor device (0): Host, Default Version Train on 60000 samples Epoch 1/5 60000/60000 [==============================] - 4s 65us/sample - loss: 0.4982 - accuracy: 0.8242 Epoch 2/5 60000/60000 [==============================] - 3s 50us/sample - loss: 0.3763 - accuracy: 0.8648 Epoch 3/5 60000/60000 [==============================] - 3s 48us/sample - loss: 0.3373 - accuracy: 0.8773 Epoch 4/5 60000/60000 [==============================] - 3s 48us/sample - loss: 0.3142 - accuracy: 0.8849 Epoch 5/5 60000/60000 [==============================] - 3s 54us/sample - loss: 0.2967 - accuracy: 0.8902「GPUではなくCPUで頑張って学習しちゃってるけど大丈夫か〜?」ってPythonに言われてるけど、大丈夫なので無視します。ちゃんと学習できてるみたいですね!素晴らしい!最終的には正解率89%くらいのモデルが出来上がりました!

正解率の評価

学習に使っていないテスト用データセットにも、ラベルがついています。これを学習が終わったモデルに流し込むことで、モデルにデータ突っ込んだら実際どのくらいの正解率になるのかを予測してみます。

tutorial.pytest_loss, test_acc = model.evaluate(test_images, test_labels, verbose=2) print('\nTest accuracy:', test_acc)正解率の予測をしてみる$ python tutorial.py 10000/10000 - 0s - loss: 0.3457 - accuracy: 0.8752 Test accuracy: 0.8752ほほう、87.5%...学習の最後のステップよりちょっと正解率下がりましたね。チュートリアル曰く、この差はいわゆる過学習の一例とのことです。学習用データセットで正解率が高くなるような学習の仕方をしすぎたせいで、他のデータが入ってきたときにモデルが「オレが知ってるデータと違う...」と疑心暗鬼になってしまう状態のことですね。な〜るほど。まぁここも今はスルーして、とりあえず実際にデータ突っ込んで結果を見てみましょう。

学習が終わったモデルで新しいデータを分類してみる

とうとうチュートリアルのゴールにたどり着きました!完成したモデルにデータを投げて、ちゃんと分類されているか見てみましょう。

tutorial.py(分類)predictions = model.predict(test_images) print(predictions[0]) print('\n This image shows ', class_names[np.argmax(predictions[0])])分類の実行$ python tutorial.py [1.1950669e-06 2.0900355e-08 8.5691376e-08 2.0669324e-07 5.3152036e-07 1.7759526e-02 7.3810802e-06 3.2051697e-02 1.6501182e-05 9.5016277e-01] This image shows Ankle boot数字だらけの配列は

入力された画像がそれぞれのラベルに分類される確率を表しています。で、結果としてこのモデルは入力された画像群の1番目をブーツであると分類したわけですね。確認のためにtest_images[0]を図示してみると...

うむ、ブーツですね!!素晴らしい!!?

ということで、チュートリアルを終え無事に身につけるモノ画像分類器が完成しました!基礎の基礎ができたので、今回はここまで!PythonもTensorFlowも完全に理解した!?(初心者特有の謎の自信)

学習に使う関数とかは確かに難しいのですが、「機械学習でなんやかんやする」だけなら細かいロジック覚えなくてもまぁなんとかなりそうだなっていうことが分かりました。

ただどっかにも書きましたが、実際にモデル構築するときはとにかくデータセット作成がめちゃくちゃ大変だなって気がします。チュートリアルでは既存のデータセットを使ったので簡単に実装できますけど、これ1から自分でデータ用意するのまじで骨折れますね...ま、次は自前でなんか作ってみます?

- 投稿日:2020-01-13T22:33:26+09:00

ジェネレーター

forループでl = ['おはよう', 'こんにちは', 'こんばんは'] for i in l: print(i)forループでの実行結果おはよう こんにちは こんばんはこれをジェネレーターを使って書くと、

ジェネレーター1def greeting(): yield 'おはよう' yield 'こんにちは' yield 'こんばんは' g = greeting() print(next(g)) print(next(g)) print(next(g))ジェネレーター1の実行結果おはよう こんにちは こんばんはジェネレーターを2つにすると、

ジェネレーター2つdef greeting(): yield 'おはよう' yield 'こんにちは' yield 'こんばんは' g = greeting() def counter(num=10): for i in range(num): yield 'ががががががー!!!' c = counter() print(next(g)) print(next(c)) print(next(c)) print(next(c)) print(next(c)) print(next(c)) print(next(g)) print(next(c)) print(next(c)) print(next(c)) print(next(c)) print(next(c)) print(next(g))ジェネレーター2つの実行結果おはよう ががががががー!!! ががががががー!!! ががががががー!!! ががががががー!!! ががががががー!!! こんにちは ががががががー!!! ががががががー!!! ががががががー!!! ががががががー!!! ががががががー!!! こんばんはforループの様に一気に処理するのではなく、

要素の生成を保持したまま、

他の処理をする事ができる。なので、

例えば下記のコードの様に、

重たい処理が途中に入っていた場合、

一気に全ての処理をするよりも、

小分けにして実装する事ができる。ジェネレーター重いdef greeting(): yield 'おはよう' for i in range(1000000): print(i) yield 'こんにちは' for i in range(1000000): print(i) yield 'こんばんは'yield 'おはよう' を処理。

for i in range(1000000):

print(i) を処理しなくもよい。次に

for i in range(1000000):

print(i)

yield 'こんにちは' を処理。という具合に小分けに処理できる。

ジェネレーターエラーdef greeting(): yield 'おはよう' yield 'こんにちは' yield 'こんばんは' g = greeting() for i in range(4): print(next(g))ジェネレーターエラーの実行時エラーTraceback (most recent call last): File "Main.py", line 9, in <module> print(next(g)) StopIterationおはよう、こんにちは、こんばんは の3つなのに、

4つprint(next(g))をしたので、

StopIteration でエラーが返ってくる。

- 投稿日:2020-01-13T22:27:20+09:00

Python初心者がとりあえず動くものを書いてみた(復習用)part1

はじめに

こんにちは。プログラミング(Python)歴約4か月の初心者です。

具体的には、TechAcademyさんの「Pythonコース」と「データサイエンスコース」を各2ヶ月ずつ受講しました。

本記事は、これまで私が学習したことを整理する目的で書きました。上記コースでどのようなことが学べるのか、また受講後にどのようなことが出来るようになるのか、参考になれば幸いです。(特に本記事では「Pythonコース」の内容を書かせて頂きます)。

不格好な部分も多々あると思いますが、よろしくお願いいたします。Pythonコースで学んだ内容

変数、オブジェクト、関数、メソッドとは?というような基礎から始まり、よく使用する構文(条件分岐if-elif-else, 繰り返しfor/while, 例外処理try-except)、シーケンス(リスト・タプル・セット・辞書)の種類と扱い、オブジェクト指向プログラミング、各ライブラリ(Numpy・Pandas・Matplotlib・Pillow・Imageio・scikit-learn)の使い方を学ぶことができました。定期的に演習課題があり、モデルデータを使用した機械学習(犬猫の画像判別、乳がんの良性悪性予測)の課題などもありました。おそらく基礎的な部分は網羅されているように思いますが、逆にDjangoやFlaskといったWebアプリケーション用のフレームワークについては範囲外になります。

さて、一通り学び終えたところで、復習も兼ねて下記の成績管理プログラムを作成してみました。もちろんテキストを見直しながら、習っていないところはググりながらですが、一応動くものを作ることが出来ました。もし私と同じように、一通りインプットを終えて何かアウトプットしてみたい方がいらっしゃいましたら、是非下記の要件だけ読んでプログラムを書いてみて下さい!きっと良い復習になると思います。

生徒の成績管理プログラム

<要件>

①“save 生徒名 点数“とすると、その生徒の点数を保存。生徒名がすでに保存されている時は、点数を上書きするか警告文を出して、yes/noで上書きの選択を行う。

②“get 生徒名“とするとその生徒の点数を表示。生徒が登録されていない場合はErrorと出力させて処理を継続。

③“quit” とするとプログラムが終了する。

④“average” すでに保存されいる生徒全員の平均点を表示する。“登録されている生徒XX人の平均点はXX.XX点です”せっかくオブジェクト指向プログラミングを学んだ(正直一番理解に苦しんだ部分でした)ため、クラスを定義しそのメソッドとして各処理を行うようにしました。

class_Score.pyclass Score: def __init__(self): self.dict={} def save(self,name,score): try: score= int(score) except : print("整数値を入力してください") else : if name in self.dict : print("生徒名:",name,"は登録されています。") ans = input("得点を上書きしますか?(yes/no):") if ans == "yes" or "Yes" or "YES": self.dict[name] = int(score) print("データが更新されました。") else : self.dict[name] = int(score) print("データが更新されました。") def get(self,name): if name in self.dict : print(name, "の得点は", self.dict[name], "点です。") else: print("エラー:データが登録されていません。") def average(self): try: ave = sum(self.dict.values())/len(self.dict.values()) except ZeroDivisionError: print("エラー:データが登録されていません。") else: print("登録されている生徒", len(self.dict), "人の平均点は", ave, "点です。")続けて別ファイルにて、上記で作ったクラスをインポート。Scoreクラスのインスタンスを作成し、条件分岐で各メソッドを実行させるよう書いてきます。

test_score.pyfrom class_Score import Score Score_data = Score() while True: data = input("コマンドを入力してください:") if data == "quit": break elif "save" in data: a, b, c = data.split() Score_data.save(name = b, score = c) elif "get" in data: d, e = data.split() Score_data.get(name = e) elif data == "average": Score_data.average() else: print("エラー:コマンドを正しく入力してください。") print("処理を終了します。")さて、実際に動くか試してみましょう。test_score.pyを実行してみると・・・

コマンドを入力してください:average エラー:データが登録されていません。 コマンドを入力してください:save Yamada 88 データが更新されました。 コマンドを入力してください:save Ishii 79 データが更新されました。 コマンドを入力してください:save Tanaka 69 データが更新されました。 コマンドを入力してください:save Yamada 89 生徒名: Yamada は登録されています。 得点を上書きしますか?(yes/no):yes データが更新されました。 コマンドを入力してください:get Yamada Yamada の得点は 89 点です。 コマンドを入力してください:average 登録されている生徒 3 人の平均点は 79.0 点です。 コマンドを入力してください:quit 処理を終了します。正常に動いていますね!

おわりに

正直なところ、動くものができただけでだいぶ感動しました(笑)。スクールの課題では、テキストを部分的に変えればできてしまうようなものも多かったため、やはり1から自分で考えてやってみるとハードな分とても勉強になるなと実感しました。また別の課題についても今後投稿してみようと思います。

まだまだ駆け出しですが、マイペースに楽しみながら学習を楽しみたいと思います!ご一読いただきありがとうございました!

- 投稿日:2020-01-13T22:21:50+09:00

グラフ理論の基礎をmatplotlibアニメーションで

- グラフ理論の基礎

- matplotlibを使ったアニメーション作成

をここでは取り扱います。

グラフ理論の基礎

グラフ理論の基礎

https://qiita.com/maskot1977/items/e1819b7a1053eb9f7d61という記事を過去に書きまして、たくさんの方から「いいね」をいただいておりますが、今回はその内容をアニメーションで分かりやすくしたいと思います。

matploblib を用いたアニメーション

簡単なアニメーションは次のようにして描けます。

# -*- coding: UTF-8 -*- import math import matplotlib.pyplot as plt import matplotlib.animation as animation from IPython.display import HTML fig = plt.figure() ims = [] # 動画=静止画の集合を格納するリスト for i in range(360): rad = math.radians(i) x1, y1 = math.cos(rad), math.sin(rad) x2, y2 = math.cos(rad * 2), math.sin(rad * 2) im = plt.scatter(x1, y1) # 静止画の部品1(リスト型ではないもの) im2 = plt.scatter(x2, y2) # 静止画の部品2(リスト型ではないもの) im3 = plt.plot([x1, x2], [y1, y2]) # 静止画の部品3(リスト型のもの) image = [im, im2] + im3 # 1つのリストが1つの静止画を表す ims.append(image) # 静止画を1つ追加する # 動画に変換する ani = animation.ArtistAnimation(fig, ims, interval=10, repeat_delay=1000) ani.save("Animation1.gif", writer='pillow') # gif ファイルとして保存 HTML(ani.to_jshtml()) # HTML上で表示

※ アニメーションが終了し停止してしまった場合、画像をクリックするともう一度動かせると思います。日本の県庁所在地データ

グラフ理論の基礎と同じデータを使います。県庁所在地の都市の座標データ(緯度・経度)が書かれています。県庁所在地の都市を「頂点」、都市と都市を結ぶ直線を「辺」と呼ぶことにします。辺で結ばれている都市は「隣接している」といいます。

import urllib.request url = 'https://raw.githubusercontent.com/maskot1977/ipython_notebook/master/toydata/location.txt' urllib.request.urlretrieve(url, 'location.txt') # データのダウンロード('location.txt', <http.client.HTTPMessage at 0x11c9c2320>)グラフ理論の基礎では使わなかった pandas を用いて読み込んでみます。

import pandas as pd japan = pd.read_csv('location.txt') japan

Town Longitude Latitude 0 Sapporo 43.06417 141.34694 1 Aomori 40.82444 140.74000 2 Morioka 39.70361 141.15250 3 Sendai 38.26889 140.87194 4 Akita 39.71861 140.10250 5 Yamagata 38.24056 140.36333 ... ... ... ... 45 Kagoshima 31.56028 130.55806 46 Naha 26.21250 127.68111 図示します。

%matplotlib inline import matplotlib.pyplot as plt plt.figure(figsize=(10, 8)) plt.scatter(japan['Latitude'], japan['Longitude']) for city, x, y in zip(japan['Town'], japan['Latitude'], japan['Longitude']): plt.text(x, y, city, alpha=0.5, size=12) plt.grid()以上のデータを使って、グラフ理論の基礎アルゴリズムである深さ優先探索・幅優先探索・最良優先探索のアニメーションを作ってみましょう。

距離行列

グラフ理論の基礎では使いませんでしたが、scipyを使えば距離行列(頂点間の距離)は次のようにして求められます。

import numpy as np from scipy.spatial import distance mat = japan[['Latitude', 'Longitude']].values dist_mat = distance.cdist(mat, mat, metric='euclidean') # ユークリッド距離2点間の直線を引くために座標を得る関数

グラフの描画で2点間の直線を引くため、辺(頂点の組)の組から座標を求める関数を自作します。

def get_edges(routes): edges = [] for route in routes: if len(route) == 2: town1, y1, x1 = [value for value in japan.values][route[0]] town2, y2, x2 = [value for value in japan.values][route[1]] edges.append([[x1, x2], [y1, y2]]) return edges使用例はこのような感じです。

get_edges([[1, 2], [3, 4], [5, 6]])[[[140.74, 141.1525], [40.82444, 39.70361]], [[140.87194, 140.1025], [38.26889, 39.71861]], [[140.36333, 140.46778], [38.240559999999995, 37.75]]]深さ優先探索

それでは、グラフ探索アルゴリズムの最初として、深さ優先探索をやります

隣接リストを得る関数1

グラフ探索では「隣接リスト」(どの頂点からどの頂点に行けるか)の作り方が非常に大切なわけですが、まずは 「ある距離(threshold)以下の頂点間に辺を結ぶ」 という方針で行ってみたいと思います。グラフ理論の基礎では使わなかったnumpyと距離行列を使えば次のようにして求められます。

def neighbor(town, dist_mat=dist_mat, threshold=1): # 隣接リストを得る関数1 return [x[0] for x in enumerate(np.where(dist_mat[town] <= threshold, True, False)) if x[1]]使用例はこんな感じ。

neighbor(12) # 東京から距離1以内の都市は?[7, 8, 9, 10, 11, 12, 13]グラフ探索関数1

グラフ理論の基礎では while 文を使ってグラフ探索問題を解いていましたが、ここでは、ステップごとに途中経過を図示したいため、探索の1ステップを進めるための関数を以下のように定義しました。

def traverse(i=0): # 深さ優先探索の1ステップ if len(stack) != 0: # スタックが空でなければ next_town, current_town = stack.pop() # 次の経路(現在地と次の都市)を得る current_direction = [[next_town, current_town]] # 描画用 if next_town not in visited_towns: # 次の都市が未訪問ならば used_routes.append([next_town, current_town]) # その経路を登録 visited_towns.append(next_town) # 訪問済みにする for nei in neighbor(next_town): # 訪問した都市に隣接する都市を1個ずつ取り出す if nei not in visited_towns: # 未訪問ならば stack.append([nei, next_town]) # 経路をスタックに入れる return current_direction # 描画用深さ優先探索アニメーション1

では、アニメーション化しましょう。

# -*- coding: UTF-8 -*- import math import matplotlib.pyplot as plt import matplotlib.animation as animation from IPython.display import HTML fig = plt.figure(figsize=(10, 8)) stack = [[12, 12]] # 始点は東京 visited_towns = [] # 訪問済みの都市を蓄える配列 used_routes = [] # 実際に使用した経路を蓄える配列 current_direction = [] # 現在チェック中の経路 ims = [] # 静止画を蓄える配列 i = 0 while len(stack) > 0: # スタックが空でなければ if i != 0: # 最初の1回は初期値を表示するため探索を進めない current_direction = traverse() # 探索を1ステップ進める image = [] # 1つの静止画に書き込む部品を蓄える配列 for edge in get_edges(stack): # 赤い線は stack に入っている「候補」の経路 image += plt.plot(edge[0], edge[1], 'r', alpha=0.5) for edge in get_edges(current_direction): # 青い線は 現在チェック中の経路 image += plt.plot(edge[0], edge[1], 'b', lw=5, alpha=0.5) for edge in get_edges(used_routes): # 黒い線は 使用済みの経路 image += plt.plot(edge[0], edge[1], 'k', lw=2) for city, x, y in zip(japan['Town'], japan['Latitude'], japan['Longitude']): image.append(plt.text(x, y, city, alpha=0.5, size=12)) # 都市名を表示 if len(current_direction) > 0: current_town = current_direction[0][0] image += plt.plot(japan.iloc[current_town, :]['Latitude'], japan.iloc[current_town, :]['Longitude'], markersize=20, marker='o') # 丸は 現在チェック中の都市 ims.append(image) # 静止画を1つ蓄える i += 1 # 動画に変換 ani = animation.ArtistAnimation(fig, ims, interval=500, repeat_delay=1000) ani.save("Animation2.gif", writer='pillow') # gifファイルとして保存 HTML(ani.to_jshtml()) # HTML上で表示深さ優先探索アニメーション1

※ アニメーションが終了し停止してしまった場合、画像をクリックするともう一度動かせると思います。隣接リストを得る関数2

上の深さ優先探索では、「最後にスタックに入った都市」が次の行き先候補になります。ある都市に移動すると、それに隣接する(複数の)都市がスタックに入ります。このとき、スタックに入れる順序を考慮することで、同じ深さ優先探索でも挙動が変わります。距離の近い都市を優先的に行き先候補に選ぶように修正しましょう。

import numpy as np def neighbor(town, dist_mat=dist_mat, threshold=1): # 隣接リストを得る関数2 return np.argsort(dist_mat[town])[1:np.where(dist_mat[town] <= threshold, 1, 0).sum()][::-1]深さ優先探索アニメーション2

以下のコードは、先ほどの「深さ優先探索アニメーション1」と同一です(保存する動画のファイル名が違うだけです)。 関数

neighborを変えると、挙動がどう変わるか確認してみましょう。# -*- coding: UTF-8 -*- # -*- coding: UTF-8 -*- import math import matplotlib.pyplot as plt import matplotlib.animation as animation from IPython.display import HTML fig = plt.figure(figsize=(10, 8)) stack = [[12, 12]] # 始点は東京 visited_towns = [] # 訪問済みの都市を蓄える配列 used_routes = [] # 実際に使用した経路を蓄える配列 current_direction = [] # 現在チェック中の経路 ims = [] # 静止画を蓄える配列 i = 0 while len(stack) > 0: # スタックが空でなければ if i != 0: # 最初の1回は初期値を表示するため探索を進めない if stack[0] != []: # 最後の表示のときも探索を進めない current_direction = traverse() # 探索を1ステップ進める image = [] # 1つの静止画に書き込む部品を蓄える配列 for edge in get_edges(stack): # 赤い線は stack に入っている「候補」の経路 image += plt.plot(edge[0], edge[1], 'r', alpha=0.5) for edge in get_edges(current_direction): # 青い線は 現在チェック中の経路 image += plt.plot(edge[0], edge[1], 'b', lw=5, alpha=0.5) for edge in get_edges(used_routes): # 黒い線は 使用済みの経路 image += plt.plot(edge[0], edge[1], 'k', lw=2) for city, x, y in zip(japan['Town'], japan['Latitude'], japan['Longitude']): image.append(plt.text(x, y, city, alpha=0.5, size=12)) # 都市名を表示 if len(current_direction) > 0: current_town = current_direction[0][0] image += plt.plot(japan.iloc[current_town, :]['Latitude'], japan.iloc[current_town, :]['Longitude'], markersize=20, marker='o') # 丸は 現在チェック中の都市 ims.append(image) # 静止画を1つ蓄える if len(stack) == 0: # 最後の表示用 current_direction = [] stack.append([]) elif stack[0] == []: # 最後の脱出用 break i += 1 # 動画に変換 ani = animation.ArtistAnimation(fig, ims, interval=500, repeat_delay=1000) ani.save("Animation3.gif", writer='pillow') # gifファイルとして保存 HTML(ani.to_jshtml()) # HTML上で表示深さ優先探索アニメーション2

※ アニメーションが終了し停止してしまった場合、画像をクリックするともう一度動かせると思います。幅優先探索

次に、幅優先探索をしてみましょう。基本アルゴリズムはほぼ同一で、スタック(先入れ後出し)をキュー(待ち行列:先入れ先出し)にするだけです。

グラフ探索関数2

関数

traverseを書き換えます。書き換える部分は「変更点」として示した1点だけです。スタックとして用いていたリストがキューに変わるので変数名stackを変えたいところですが、そうすると書き換える部分が多くなってしまうので、stackはそのままにしときましょう。def traverse(i=0): # 幅優先探索の1ステップ if len(stack) != 0: next_town, current_town = stack.pop(0) # 変更点 current_direction = [[next_town, current_town]] if next_town not in visited_towns: used_routes.append([next_town, current_town]) visited_towns.append(next_town) for nei in neighbor(next_town): if nei not in visited_towns: stack.append([nei, next_town]) return current_direction隣接リストを得る関数3

隣接リストを得る関数も書き換えますが、基本的には前のものとほとんど同一です。スタックがキューになるので、順番をひっくり返すだけです。

import numpy as np def neighbor(town, dist_mat=dist_mat, threshold=1): # 隣接リストを得る関数3 return np.argsort(dist_mat[town])[1:np.where(dist_mat[town] <= threshold, 1, 0).sum()] # 末尾だけ変更幅優先探索アニメーション

以下のコードも、先ほどの「深さ優先探索アニメーション1」「深さ優先探索アニメーション2」と同一です(保存する動画のファイル名が違うだけです)。 関数

traverseを変えると、挙動がどう変わるか確認してみましょう。# -*- coding: UTF-8 -*- import math import matplotlib.pyplot as plt import matplotlib.animation as animation from IPython.display import HTML fig = plt.figure(figsize=(10, 8)) stack = [[12, 12]] # 始点は東京 visited_towns = [] # 訪問済みの都市を蓄える配列 used_routes = [] # 実際に使用した経路を蓄える配列 current_direction = [] # 現在チェック中の経路 ims = [] # 静止画を蓄える配列 i = 0 while len(stack) > 0: # スタックが空でなければ if i != 0: # 最初の1回は初期値を表示するため探索を進めない if stack[0] != []: # 最後の表示のときも探索を進めない current_direction = traverse() # 探索を1ステップ進める image = [] # 1つの静止画に書き込む部品を蓄える配列 for edge in get_edges(stack): # 赤い線は stack に入っている「候補」の経路 image += plt.plot(edge[0], edge[1], 'r', alpha=0.5) for edge in get_edges(current_direction): # 青い線は 現在チェック中の経路 image += plt.plot(edge[0], edge[1], 'b', lw=5, alpha=0.5) for edge in get_edges(used_routes): # 黒い線は 使用済みの経路 image += plt.plot(edge[0], edge[1], 'k', lw=2) for city, x, y in zip(japan['Town'], japan['Latitude'], japan['Longitude']): image.append(plt.text(x, y, city, alpha=0.5, size=12)) # 都市名を表示 if len(current_direction) > 0: current_town = current_direction[0][0] image += plt.plot(japan.iloc[current_town, :]['Latitude'], japan.iloc[current_town, :]['Longitude'], markersize=20, marker='o') # 丸は 現在チェック中の都市 ims.append(image) # 静止画を1つ蓄える if len(stack) == 0: # 最後の表示用 current_direction = [] stack.append([]) elif stack[0] == []: # 最後の脱出用 break i += 1 # 動画に変換 ani = animation.ArtistAnimation(fig, ims, interval=500, repeat_delay=1000) ani.save("Animation4.gif", writer='pillow') # gifファイルとして保存 HTML(ani.to_jshtml()) # HTML上で表示幅優先探索アニメーション

※ アニメーションが終了し停止してしまった場合、画像をクリックするともう一度動かせると思います。最良優先探索と最小木

最後に、最良優先探索 です。上2つの探索では、スタック(またはキュー)に追加するときに、距離の短い都市が優先的に取り出されるように追加しました。最良優先探索では、追加された後のスタック(実際はキュー)全体をソートして、その中から距離の短い都市を優先的に取り出すようにします。その結果として「最小木」ができあがります。

スタックを並び直す関数

これまでとの変更点は、スタック全体をソートし直すだけです。

def sort_stack(stack): return [stack[i] for i in np.argsort([dist_mat[edge[0]][edge[1]] for edge in stack])]最良優先探索アニメーション

以下のコードは、今までのと基本的に同じです。変更点は関数

sort_stackが追加されたことと、動画を保存するファイル名を変えただけです。# -*- coding: UTF-8 -*- import math import matplotlib.pyplot as plt import matplotlib.animation as animation from IPython.display import HTML fig = plt.figure(figsize=(10, 8)) stack = [[12, 12]] # 始点は東京 visited_towns = [] # 訪問済みの都市を蓄える配列 used_routes = [] # 実際に使用した経路を蓄える配列 current_direction = [] # 現在チェック中の経路 ims = [] # 静止画を蓄える配列 i = 0 while len(stack) > 0: # スタックが空でなければ if i != 0: # 最初の1回は初期値を表示するため探索を進めない if stack[0] != []: # 最後の表示のときも探索を進めない stack = sort_stack(stack) # 最良優先探索のためにスタックをソート current_direction = traverse() # 探索を1ステップ進める image = [] # 1つの静止画に書き込む部品を蓄える配列 for edge in get_edges(stack): # 赤い線は stack に入っている「候補」の経路 image += plt.plot(edge[0], edge[1], 'r', alpha=0.5) for edge in get_edges(current_direction): # 青い線は 現在チェック中の経路 image += plt.plot(edge[0], edge[1], 'b', lw=5, alpha=0.5) for edge in get_edges(used_routes): # 黒い線は 使用済みの経路 image += plt.plot(edge[0], edge[1], 'k', lw=2) for city, x, y in zip(japan['Town'], japan['Latitude'], japan['Longitude']): image.append(plt.text(x, y, city, alpha=0.5, size=12)) # 都市名を表示 if len(current_direction) > 0: current_town = current_direction[0][0] image += plt.plot(japan.iloc[current_town, :]['Latitude'], japan.iloc[current_town, :]['Longitude'], markersize=20, marker='o') # 丸は 現在チェック中の都市 ims.append(image) # 静止画を1つ蓄える if len(stack) == 0: # 最後の表示用 current_direction = [] stack.append([]) elif stack[0] == []: # 最後の脱出用 break i += 1 # 動画に変換 ani = animation.ArtistAnimation(fig, ims, interval=500, repeat_delay=1000) ani.save("Animation5.gif", writer='pillow') # gifファイルとして保存 HTML(ani.to_jshtml()) # HTML上で表示最良優先探索アニメーション

※ アニメーションが終了し停止してしまった場合、画像をクリックするともう一度動かせると思います。

- 投稿日:2020-01-13T22:15:07+09:00

pipって何、どう使うの?

pipってなに?

pipはpythonのパッケージマネージャの一つです、他にはcondaやpipenvなどがあります。

python3系ではバージョン3.4以降であれば、pythonのインストールと共にpipもインストールされます。

pythonの標準ライブラリに含まれないパッケージのインストールや管理をすることができます。仮想環境でpipの使い方を見ていきましょう

pipを使えるかチェック:

$ pip --version pip 10.0.1 from /Users/場所/venv/lib/python3.7/site-packages/pip (python 3.7)pipのアップデート

$ pip install --upgrade pippipのバージョン再チェック

$ pip --version pip 19.3.1 from /Users/場所/venv/lib/python3.7/site-packages/pip (python 3.7)pipで使えるコマンド達を見てみましょう:

$ pip help Usage: pip <command> [options] Commands: install Install packages. download Download packages. uninstall Uninstall packages. freeze Output installed packages in requirements format. list List installed packages. show Show information about installed packages. check Verify installed packages have compatible dependencies. config Manage local and global configuration. search Search PyPI for packages. wheel Build wheels from your requirements. hash Compute hashes of package archives. completion A helper command used for command completion. debug Show information useful for debugging. help Show help for commands. General Options: -h, --help Show help. --isolated Run pip in an isolated mode, ignoring environment variables and user configuration. -v, --verbose Give more output. Option is additive, and can be used up to 3 times. -V, --version Show version and exit. -q, --quiet Give less output. Option is additive, and can be used up to 3 times (corresponding to WARNING, ERROR, and CRITICAL logging levels). --log <path> Path to a verbose appending log. --proxy <proxy> Specify a proxy in the form [user:passwd@]proxy.server:port. --retries <retries> Maximum number of retries each connection should attempt (default 5 times). --timeout <sec> Set the socket timeout (default 15 seconds). --exists-action <action> Default action when a path already exists: (s)witch, (i)gnore, (w)ipe, (b)ackup, (a)bort. --trusted-host <hostname> Mark this host or host:port pair as trusted, even though it does not have valid or any HTTPS. --cert <path> Path to alternate CA bundle. --client-cert <path> Path to SSL client certificate, a single file containing the private key and the certificate in PEM format. --cache-dir <dir> Store the cache data in <dir>. --no-cache-dir Disable the cache. --disable-pip-version-check Don't periodically check PyPI to determine whether a new version of pip is available for download. Implied with --no-index. --no-color Suppress colored outputパッケージをpipでインストール

pythonの標準ライブラリは充実していますが、それ以外にも世界中の開発者が製作したpythonのフレームワーク、ツール、ライブラリなどがPython Package Index(PyPI)にて公開されています。(パイピーアイと読みます、パイパイではないです。)

現在の環境にインストールされているパッケージをpip listでチェック(まだ何もインストールしていない状態):$ pip list Package Version ---------- ------- pip 19.3.1 setuptools 39.0.1PyPIから使いたいパッケージをインストールするためにはpip installコマンドを使います。

機械学習ライブラリscikit-learnを使いたいとなったら:$ pip install scikit-learn Collecting scikit-learn Downloading https://files.pythonhosted.org/packages/82/d9/69769d4f79f3b719cc1255f9bd2b6928c72f43e6f74084e3c67db86c4d2b/scikit_learn-0.22.1-cp37-cp37m-macosx_10_6_intel.whl (11.0MB) |████████████████████████████████| 11.0MB 851kB/s Collecting scipy>=0.17.0 Using cached https://files.pythonhosted.org/packages/85/7a/ae480be23b768910a9327c33517ced4623ba88dc035f9ce0206657c353a9/scipy-1.4.1-cp37-cp37m-macosx_10_6_intel.whl Collecting joblib>=0.11 Downloading https://files.pythonhosted.org/packages/28/5c/cf6a2b65a321c4a209efcdf64c2689efae2cb62661f8f6f4bb28547cf1bf/joblib-0.14.1-py2.py3-none-any.whl (294kB) |████████████████████████████████| 296kB 1.1MB/s Collecting numpy>=1.11.0 Using cached https://files.pythonhosted.org/packages/2f/5b/2cc2b9285e8b2ca8d2c1e4a2cbf1b12d70a2488ea78170de1909bca725f2/numpy-1.18.1-cp37-cp37m-macosx_10_9_x86_64.whl Installing collected packages: numpy, scipy, joblib, scikit-learn Successfully installed joblib-0.14.1 numpy-1.18.1 scikit-learn-0.22.1 scipy-1.4.1現在の環境にインストールされているパッケージをチェック:

$ pip list Package Version ------------ ------- joblib 0.14.1 numpy 1.18.1 pip 19.3.1 scikit-learn 0.22.1 scipy 1.4.1 setuptools 39.0.1scikit-learnをインストールしただけなのにscikit-learn以外にjoblib、numpy、scipyがインストールされている。これはscikit-learnが他のパッケージjoblib、numpy、scipyに依存しているからです。つまりscikit-learn単体では動かないので、必要とされる他のパッケージを一緒にインストールしてくれたのです。

pip show コマンドでインストールしたパッケージのバージョンや依存情報を確認できます:

$ pip show scikit-learn Name: scikit-learn Version: 0.22.1 Summary: A set of python modules for machine learning and data mining Home-page: http://scikit-learn.org Author: None Author-email: None License: new BSD Location: /Users/場所/venv/lib/python3.7/site-packages Requires: scipy, joblib, numpy Required-by:Requires: scipy, joblib, numpyなのでscikit-learnはscipy, joblib, numpyに依存していることが確認できます。

Required-by: が空欄になっているので、今の所scikit-learnに依存しているパッケージはないことを確認できます。一緒にインストールされたscipyも見てみましょう:

$ pip show scipy Name: scipy Version: 1.4.1 Summary: SciPy: Scientific Library for Python Home-page: https://www.scipy.org Author: None Author-email: None License: BSD Location: /Users/場所/venv/lib/python3.7/site-packages Requires: numpy Required-by: scikit-learnscipyはnumpyが必要で、scikit-learnに必要とされていることがわかります。

pip installは常に公開されている最新のバージョンをインストールするため、ある決まったバージョンのパッケージをインストールしたい時は、バージョンを明記する必要がある。

例えばscikit-learnの最新バージョンは0.22.1だが、バージョン0.21.3をインストールしたければ:$ pip install scikit-learn==0.21.3 Collecting scikit-learn==0.21.3 Using cached https://files.pythonhosted.org/packages/e9/57/8a9889d49d0d77905af5a7524fb2b468d2ef5fc723684f51f5ca63efed0d/scikit_learn-0.21.3-cp37-cp37m-macosx_10_6_intel.macosx_10_9_intel.macosx_10_9_x86_64.macosx_10_10_intel.macosx_10_10_x86_64.whl Requirement already satisfied: scipy>=0.17.0 in ./venv/lib/python3.7/site-packages (from scikit-learn==0.21.3) (1.4.1) Requirement already satisfied: joblib>=0.11 in ./venv/lib/python3.7/site-packages (from scikit-learn==0.21.3) (0.14.1) Requirement already satisfied: numpy>=1.11.0 in ./venv/lib/python3.7/site-packages (from scikit-learn==0.21.3) (1.18.1) Installing collected packages: scikit-learn Found existing installation: scikit-learn 0.22.1 Uninstalling scikit-learn-0.22.1: Successfully uninstalled scikit-learn-0.22.1 Successfully installed scikit-learn-0.21.3scikit-learn-0.22.1をすでにインストールしていた状態でも、まずアンインストールしてから指定したバージョンをインストールしてくれます。joblib、numpy、scipyに関しては、すでにインストールしている、かつscikit-learn-0.21.3が必要としている条件を満たしているのでそのままにしてくれます。

複数のパッケージのバージョンを指定してインストールしたい時、まとめてrequirements.txt(名前はなんでもいい)に書いてpip installできます。

$ cat requirements.txt joblib==0.14.1 numpy==1.18.1 scikit-learn==0.21.3 scipy==1.4.1$ pip install -r requirements.txt Collecting joblib==0.14.1 Using cached https://files.pythonhosted.org/packages/28/5c/cf6a2b65a321c4a209efcdf64c2689efae2cb62661f8f6f4bb28547cf1bf/joblib-0.14.1-py2.py3-none-any.whl Collecting numpy==1.18.1 Using cached https://files.pythonhosted.org/packages/2f/5b/2cc2b9285e8b2ca8d2c1e4a2cbf1b12d70a2488ea78170de1909bca725f2/numpy-1.18.1-cp37-cp37m-macosx_10_9_x86_64.whl Collecting scikit-learn==0.21.3 Using cached https://files.pythonhosted.org/packages/e9/57/8a9889d49d0d77905af5a7524fb2b468d2ef5fc723684f51f5ca63efed0d/scikit_learn-0.21.3-cp37-cp37m-macosx_10_6_intel.macosx_10_9_intel.macosx_10_9_x86_64.macosx_10_10_intel.macosx_10_10_x86_64.whl Collecting scipy==1.4.1 Using cached https://files.pythonhosted.org/packages/85/7a/ae480be23b768910a9327c33517ced4623ba88dc035f9ce0206657c353a9/scipy-1.4.1-cp37-cp37m-macosx_10_6_intel.whl Installing collected packages: joblib, numpy, scipy, scikit-learn Successfully installed joblib-0.14.1 numpy-1.18.1 scikit-learn-0.21.3 scipy-1.4.1現在の環境を別のプロジェクトなどに複製したい時はpip freezeコマンドで現在の環境を丸ごとファイルに書き出すことができます:

$ pip freeze > requirements.txt $ cat requirements.txt joblib==0.14.1 numpy==1.18.1 scikit-learn==0.21.3 scipy==1.4.1'==' 以外にも'<='、 '>='などの条件をつけることができます。requirement-specifiers

例えばscikit-learn>=0.21.3という条件にした場合:$ cat requirements.txt joblib==0.14.1 numpy==1.18.1 scikit-learn>=0.21.3 scipy==1.4.1現在の環境チェック:

$ pip list Package Version ------------ ------- joblib 0.14.1 numpy 1.18.1 pip 19.3.1 scikit-learn 0.21.3 scipy 1.4.1 setuptools 39.0.1pip install -r requirements.txtしてみる:

$ pip install -r requirements.txt Requirement already satisfied: joblib==0.14.1 in ./venv/lib/python3.7/site-packages (from -r requirements.txt (line 1)) (0.14.1) Requirement already satisfied: numpy==1.18.1 in ./venv/lib/python3.7/site-packages (from -r requirements.txt (line 2)) (1.18.1) Requirement already satisfied: scikit-learn>=0.21.3 in ./venv/lib/python3.7/site-packages (from -r requirements.txt (line 3)) (0.21.3) Requirement already satisfied: scipy==1.4.1 in ./venv/lib/python3.7/site-packages (from -r requirements.txt (line 4)) (1.4.1)requirements.txtに記述されている条件を満たしていると言われる。まーscikit-learn 0.21.3はscikit-learn>=0.21.3を確かに満たしている。

条件を満たす最新のバージョンにアップデートして欲しい時には--upgrade:$ pip install --upgrade -r requirements.txt Requirement already up-to-date: joblib==0.14.1 in ./venv/lib/python3.7/site-packages (from -r requirements.txt (line 1)) (0.14.1) Requirement already up-to-date: numpy==1.18.1 in ./venv/lib/python3.7/site-packages (from -r requirements.txt (line 2)) (1.18.1) Collecting scikit-learn>=0.21.3 Using cached https://files.pythonhosted.org/packages/82/d9/69769d4f79f3b719cc1255f9bd2b6928c72f43e6f74084e3c67db86c4d2b/scikit_learn-0.22.1-cp37-cp37m-macosx_10_6_intel.whl Requirement already up-to-date: scipy==1.4.1 in ./venv/lib/python3.7/site-packages (from -r requirements.txt (line 4)) (1.4.1) Installing collected packages: scikit-learn Found existing installation: scikit-learn 0.21.3 Uninstalling scikit-learn-0.21.3: Successfully uninstalled scikit-learn-0.21.3 Successfully installed scikit-learn-0.22.1また、requirementsファイルの中にrequirementsファイルを書くこともできます: