- 投稿日:2019-06-27T23:57:27+09:00

傾向スコアを用いた因果効果推定(IPW,DR推定量)【実験編】

はじめに

理論編で述べた内容を簡単に人工データで試してみよう、という内容です。

実験

因果効果の推定の数値実験はいろいろネットに転がってて、データセットとかも現実のものを使っても良いのですが、問題の性質上、人工データでやったほうが因果と相関がどれくらい異なっているかという真のモデルがわかって結果の解釈がしやすいので、今回は自分でデータを生成して因果効果を推定してみます。

単純にMD(Mean difference)を調べると実際の因果効果よりも大きく見えてしまうデータを生成し、そのようなデータに対してIPW推定量やDR推定量を用いて因果効果の推定を行うと、正しく真の因果効果に近い値を示すことを確認します。

MDの定義は理論編にありますが、念のため再掲します。

詳しくは前回の記事を参照してください。MD=\frac{\sum_i^n z_i y_i}{\sum_i^n z_i}-\frac{\sum_i^n (1-z_i) y_i}{\sum_i^n (1-z_i)}以下のようにデータを生成します。

最初に$z=1,z=0$のデータを半分ずつ作り、それを元に以下のようにして特徴量$x_e,x_{ne}$や結果変数$y$を作ります。

x_e = 3z + \epsilon_1\\ x_{ne} \sim N(1,1)\\ y = 1+2x_e+3x_{ne} + 10z + \epsilon_2\\ \epsilon_1,\epsilon_2 \sim N(0,1)$x_e$は$z$と$y$とともに変化する共変量です。

$x_{ne}$は$z$に影響しません。結果変数は、$z=1$のデータのときは$z=0$の時よりも10だけ大きい値をとるようにします。

このように生成したデータについて、$z$の$y$への因果効果($y$の増加に$z$がどれだけ寄与しているか)は、

- $z$自体が直接$y$に与えている影響 : 10

- $z$とともに変化する$x_e$由来の$y$への影響 : $3\times 2=6$

今回のように$z$が先にあって$x_e$がそれに伴って作られていると2個目の影響も因果効果に見えますが、$x_e$由来の$y$への影響分は純粋な$z$による効果ではないので、因果効果には含みません。

なので、気持ちとしては

単純に集団ごとの平均の差を見ると16程度の偏りがあるが、実際の因果効果はそのうちの10だけで、残りの6は共変量による見かけの影響である

ようなデータです。

このようにして生成したデータに対して、MD,IPW,DRの3つの推定量を計算してみます。

結果がこちら。

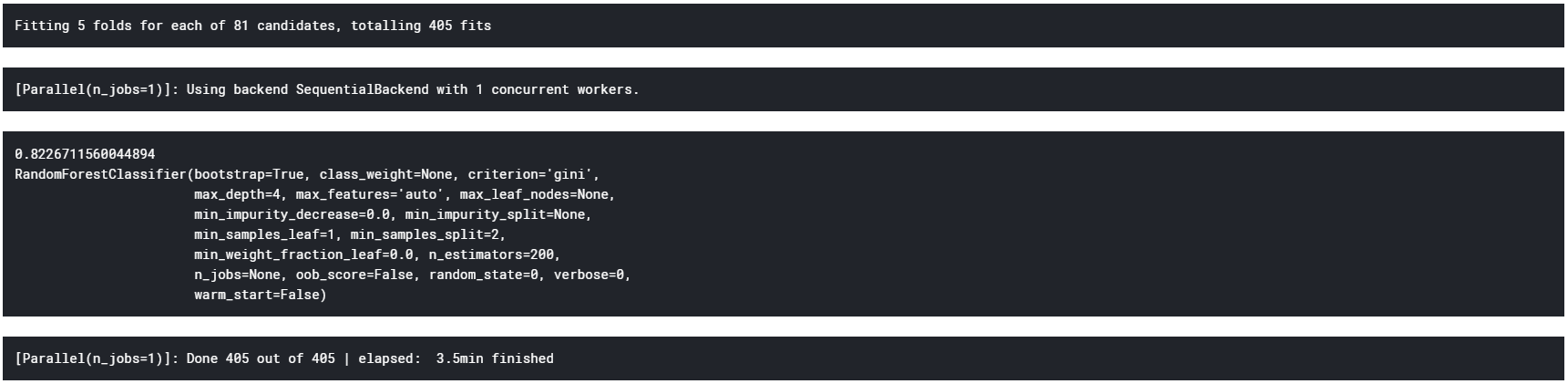

指標 値 MD 16.0 IPW 12.4 DR 9.9 単純なMDでは、先に説明した影響の両方(10と6)をどちらも見てしまうので約16になっていて、IPWやDRはそれより小さく10に近い値、すなわち真の因果効果に近い値を正しく推定できています。(IPWはちょっと外れていますが)

おまけに、データ生成の際に乗せていたノイズを小さくした(0.1倍)綺麗なデータについても実験を行いました。

結果がこちら。

指標 値 MD 16.0 IPW 16.0 DR 10.0 面白いことに、IPWがMDとほぼ一致します。

これは、ノイズがなくなったことにより傾向スコアのモデルが$z=1$のデータに対しては$e=1$、$z=0$のデータに対しては$e=0$に近い値を算出するようになったことが原因と考えられます。このような傾向スコアのモデリングは正しくないため、傾向スコアのモデリングの正しさにのみ依存するIPW推定量は、真の因果効果の不偏推定量になってくれず、見かけの相関のMDと一致してしまいます。

実際、定義からそのような傾向スコアを用いてIPW推定量を計算した場合、MDにほぼ一致します。

一方、傾向スコアのモデリングを外していても、潜在結果変数のモデリングが正しくできているため、DR推定量は真の因果効果である10をバイアスなく推定することができています。

ソースコード

因果推論の実験とかだとRを使ったものが多いので、あえてPythonで書いてみました。

データ生成部分。

regression_generator.pyclass RegressionGenerator(GeneratorInterface): """回帰問題用のデータセットを生成するクラス. x_e = s_to_xe * s + coef_noize * epsilon x_ne ~ N(mu,sigma^2) : iid w = [1,2,3,1,2,3,1,2,3...] features_n : x_e と x_neの個数合計 y_1 = w * [x_1, x_i] + c + coef_noize * epsilon y_0 = w * [x_1, x_i] + coef_noize * epsilon """ def __init__(self, s_to_x_e, c, features_n=2, seed=0, p=0.5, mu=1, sigma2=1, coef_noize=1): """Initialize genrator instance.""" w = np.array(([1, 2, 3] * (features_n // 3 + 1))[:features_n + 1]) self.seed = seed self.s_to_x_e = s_to_x_e self.w = w self.mu = mu self.p = p self.sigma2 = sigma2 self.coef_noize = coef_noize self.c = c self.features_n = features_n def run(self, num): """Generate raw dataset.""" seed(self.seed) s1_num = int(self.p * num) s = [1 for _ in range(s1_num)] + [0 for _ in range(num - s1_num)] x_e = [self.s_to_x_e * e + self.coef_noize * randn() for e in s] x_ne = np.array([[normal(self.mu, self.sigma2) for i in range(self.features_n - 1)] for _ in range(num)]) y = [] for i in range(len(s)): x = np.concatenate([np.array([1, x_e[i]]), x_ne[i]]) y.append(np.dot(self.w, x) + s[i] * self.c + self.coef_noize * randn()) df = pd.DataFrame() df["x_e"] = x_e for i in range(self.features_n - 1): df[f"x_ne{i+1}"] = x_ne[:, i] df["s"] = s df["y"] = y df = df.reindex(np.random.RandomState(self.seed).permutation( df.index)).reset_index(drop=True) return df各推定量の計算はこんなかんじ。

analyze.pydef get_md(s, y): """MDを返す. input s(numpy) y(numpy) yはラベル1となる確率が各要素 return md """ ys = y[s == 1] yns = y[s == 0] md = ys.mean() - yns.mean() return md def get_ipw(y, s, e): """IPW推定量を計算する.""" Ey1 = (s * y / e).sum() / (s / e).sum() Ey0 = ((1 - s) * y / (1 - e)).sum() / ((1 - s) / (1 - e)).sum() return Ey1 - Ey0 def get_dr(y, s, e, g0, g1): """DR推定量を計算する.""" Ey1 = (s * y / e + (1 - s / e) * g1).mean() Ey0 = ((1 - s) * y / (1 - e) + (1 - (1 - s) / (1 - e)) * g0).mean() return Ey1 - Ey0おわりに

前回の記事で紹介した因果推論の傾向スコアを用いた推定(IPW,DR推定量)について、人工データを用いて簡単な実験を行いました。

ありがとうございました。

- 投稿日:2019-06-27T23:54:22+09:00

InfluxDBをPythonから使う

InfluxDBをPythonから使う

InfluxDataがInfluxDB-Pythonというライブラリを用意してくれているのでそれを使えば良いだけ。

参考サイト

https://github.com/influxdata/influxdb-python

InfluxDB-Pythonのインストール

pip3 install influxdb --user pip3 install --upgrade influxdb --user依存関係

InfluxDB-PythonディストリビューションはPython 2.7, 3.5, 3.6, 3.7, そしてPyPyとPyPy3上ででサポートされていてテスト済みである。

注意: Python <3.5 は現在テストされていない。

主な依存関係は:

- Requests: HTTP library for human beings (http://docs.python-requests.org/)

他の依存関係は:

- pandas: for writing from and reading to DataFrames (http://pandas.pydata.org/)

- Sphinx: Tool to create and manage the documentation (http://sphinx-doc.org/)

- Nose: to auto-discover tests (http://nose.readthedocs.org/en/latest/)

- Mock: to mock tests (https://pypi.python.org/pypi/mock)

ドキュメント

ドキュメントはココ

例

>>> from influxdb import InfluxDBClient >>> json_body = [ { "measurement": "cpu_load_short", "tags": { "host": "server01", "region": "us-west" }, "time": "2009-11-10T23:00:00Z", "fields": { "value": 0.64 } } ] >>> >>> json_body [{'measurement': 'cpu_load_short', 'tags': {'host': 'server01', 'region': 'us-west'}, 'time': '2009-11-10T23:00:00Z', 'fields': {'value': 0.64}}] >>> client = InfluxDBClient('localhost', 8086, 'root', 'root', 'example') >>> client <influxdb.client.InfluxDBClient object at 0x7f4fea0c4ef0> >>> client.create_database('example') >>> client.write_points(json_body) True >>> result = client.query('select value from cpu_load_short;') >>> print("Result: {0}".format(result)) Result: ResultSet({'('cpu_load_short', None)': [{'time': '2009-11-10T23:00:00Z', 'value': 0.64}]})テスト

toxをインストールする:

$ pip3 install tox --user複数のバージョンのPythonに対してinfluxdb-pythonをテストするためには、Toxを使うことが出来る:

$ tox

- 投稿日:2019-06-27T23:37:30+09:00

我为中国人创作了翻译。

私は中国語への翻訳機を作成しました

日本語の文章を構文解析して日本人が読める偽中国語翻訳機を作った記事『我偽中国語翻訳機作成了』が、たくさんいいねされていてうらやましい。

構文解析しなくても近いものが翻訳APIでちょちょいとできるんじゃね、と思ってやってみた。

以前に使ってみたことがあったので、IBM Cloud の Language Translator を使った。

でも、Language Translator の既存の翻訳言語モデルに

日本語から中国語へ直接変換するモデルは現時点ではないみたい。

英語は各言語に直接変換するモデルがあるみたい。

翻訳言語 モデル 日本語 ⇔ 英語 あり 中国語 ⇔ 英語 あり 日本語 ⇔ 中国語 なし ということで英語を中継して中国語を作成するプログラムにします。

発言 ➡ 中継 ➡ 最終 日本語 ➡ 英語 ➡ 中国語 以前に同じようなことをやりました。

Watson APIを利用してPythonで多言語通訳botをSlackに作るIBM Cloud - Language Translator の利用準備

- IBM Cloudのアカウントを作成

- Language Translator のサービスインスタンス作成

- 作成したインスタンスのサービス資格情報から apikey を取得

こちらの url でインスタンス作成

IBM Cloud - Language Translatorアカウント作成からインスタンス作成まで こちらの記事 参考。サービスのバージョンアップで画面イメージが違っていますが、やることは同じです。

- pythonライブラリ ibm-watson のインストール

pip install --upgrade ibm-watsonIBM Cloud APIを使って翻訳してみる

実装

watson_language_translator.pyfrom ibm_watson import LanguageTranslatorV3 language_translator = LanguageTranslatorV3( version='2018-05-01', iam_apikey='{apikey}', url='https://gateway.watsonplatform.net/language-translator/api' ) langs = [['ja','日'], ['en','英'], ['zh-cn','中']] # langs = [開始言語, 中継言語, 出力言語] for _ in range(10): print('■ 日本語を入力してね。1回英語を中継して、中国語に翻訳するよ。') text = input('%s> ' % (langs[0][1],)) for i in range(len(langs)-1): translation = language_translator.translate( text=text, source=langs[i][0], target=langs[i+1][0]) text = translation.result['translations'][0]['translation'] print('%s:%s' % (langs[i+1][1], text,)) print()結果

>python watson_language_translator.py ■ 日本語を入力してね。1回英語を中継して、中国語に翻訳するよ。 日> 私は中国語への翻訳機を作成しました 英:I have created a translator for Chinese. 中:我为中国人创作了翻译。 ■ 日本語を入力してね。1回英語を中継して、中国語に翻訳するよ。 日> 私はお酒を飲みたい 英:I want to drink. 中:我想喝 ■ 日本語を入力してね。1回英語を中継して、中国語に翻訳するよ。 日> 私は本日定時退社します 英:I'm leaving the company today. 中:我今天要离开公司 ■ 日本語を入力してね。1回英語を中継して、中国語に翻訳するよ。 日> 私は理解しました 英:I understood. 中:我明白了 ■ 日本語を入力してね。1回英語を中継して、中国語に翻訳するよ。 日> 私は明日、伊豆大島に行きたい 英:I want to go to Izu Oshima tomorrow. 中:我明天要去伊豆大岛 ■ 日本語を入力してね。1回英語を中継して、中国語に翻訳するよ。 日> 私は昨日、日本の料理を食べました 英:Yesterday, I ate Japanese food. 中:昨天我吃了日本菜 ■ 日本語を入力してね。1回英語を中継して、中国語に翻訳するよ。 日> 今日は10時に仕事が終わります 英:I'm done at 10 o'clock today. 中:我今天十点就完成了 ■ 日本語を入力してね。1回英語を中継して、中国語に翻訳するよ。 日> あなたは何時に終わりますか? 英:What time do you end up? 中:你几点结束?結論

- 日本人の読める偽中国語は、翻訳APIで作れなかった。

中国語はむずかしいってこと。

- 英語を経由することで中国語に翻訳した時には意味、情報が落ちるケースがあった。

ひとつの英単語で広い意味を持ってたりするため。

例えば drink だけで、酒を飲むという意味がある。

- 投稿日:2019-06-27T23:20:08+09:00

超小ネタ 引数に渡した数値型の全てが0を除き同じ符号かを判定する

コード

def is_same_sign(*numbers) -> bool: return len({x > 0 for x in numbers if x != 0}) <= 1テスト

assert is_same_sign(*[1, 5, 0]) assert not is_same_sign(*[-1, 5, 0]) assert is_same_sign(*[0, 0, 0, 0])解説

関数

is_same_signは、set内包表記を用いて、引数の中で0でないなら、0より大でTrue、0より小ならFalseとするboolのsetを作る。

このsetは

-set(): 長さ0の空set

-{True}か{False}: 長さ1のset

-{True, False}か{False, True}: 長さ2のset

となり、全て符号が同じ =setの要素数が0または1 = 要素数が1以下ということができる。以上。

- 投稿日:2019-06-27T23:12:18+09:00

VRゲームで自身をアバターとして表示して録画する方法と、その撮影するカメラを自動で動かす手段を考えてみた話

VRゲームで自身をアバターとして表示して録画する

手持ち無沙汰でなんとなくTwitterのTLを見ていると、VRのゲームを録画した映像にキャラクターが合成された動画が流れてくることが(多分)何回かはあると思います。

あれはどう実現されているかというとゲームのMODだったりいろいろと手はありますがここではLIVとバーチャルモーションキャプチャーを使った方法について書きます。LIVは、グリーンバック(以下GB)の前に人がいるカメラ映像と三人称視点で表示したVRのゲーム画面を合成するソフトです。

バーチャルモーションキャプチャーは、SteamVRから手や頭の位置情報を取得してアバターを動かしGBで表示するめっちゃ便利なソフトです。あきら氏(@sh_akira)が開発しています。

LIVへの『GB撮影されたカメラ映像』の代わりに『GBの前で動くアバターの映像』を仮想webカメラとして流し込むことで、VRゲームの中でアバターが動いているような映像になります。

撮影するカメラを動かしたい

LIVとバーチャルモーションキャプチャーを使用した動画で今一番出回っているのはBeat Saberだと思われます。

その動画を見ると大体初めから終わりまで背後から固定したカメラでの映像です。

自分で撮影してみると、もっとアバターを別アングルで見てみたいとか絵的に派手にしたいとか欲が出てきます。

Beat Saberに限れば、MODのみでアバターを合成したり三人称視点にしてカメラを動かしたりは可能なようです。https://www.youtube.com/watch?v=ivBVDMMO_YA

しかし、他のゲームでも同じようなことをするためにはMODに頼らずにどうにかする必要があります。

LIVにはVRデバイスに三人称視点のカメラを割り当てる機能があります。

誰かにVIVEのトラッカーやコントローラーを持ってもらってプレイヤーの周りを動いて撮影することはできますが、手ブレの問題があったり、何よりも一人では無理です。コントローラーをプログラム的に動かす手が無いかとぼんやり考えながら過ごしていたところ、VR内から画像ファイルやデスクトップを見れる超絶便利なツールVaNiiMenu開発者のgpsnmeajp氏(@Seg_Faul)がコントローラードライバのサンプルコードを公開されていました。

そのサンプルコードではクライアントがドライバの共有メモリに座標を書き込んで、仮想のコントローラーを移動させることができるようになっていました。

クライアントのC++のコードを参考にPythonで書いてみたのがこれです。

simpleShareMemWrite.pyimport mmap shareMem = mmap.mmap(0,16384,'pip1') cameraPos = [0,1.5,-1] #単位はメートル これで高さ1.5m 前方1m posX = str(cameraPos[0]) posY = str(cameraPos[1]) posZ = str(cameraPos[2]) shareMem.seek(0) shareMem.write(b'{"id":0,"v":['+posX.encode()+b','+posY.encode()+b','+posZ.encode()\ +b'],"vd":[0,0,0],"vdd":[0,0,0],"r":[0,0,0,0],"rd":[0,0,0],"rdd":[0,0,0],"Valid":true}')サンプルのドライバを入れた状態でスクリプトを動かすと目の前にベースステーションのモデルが移動します。

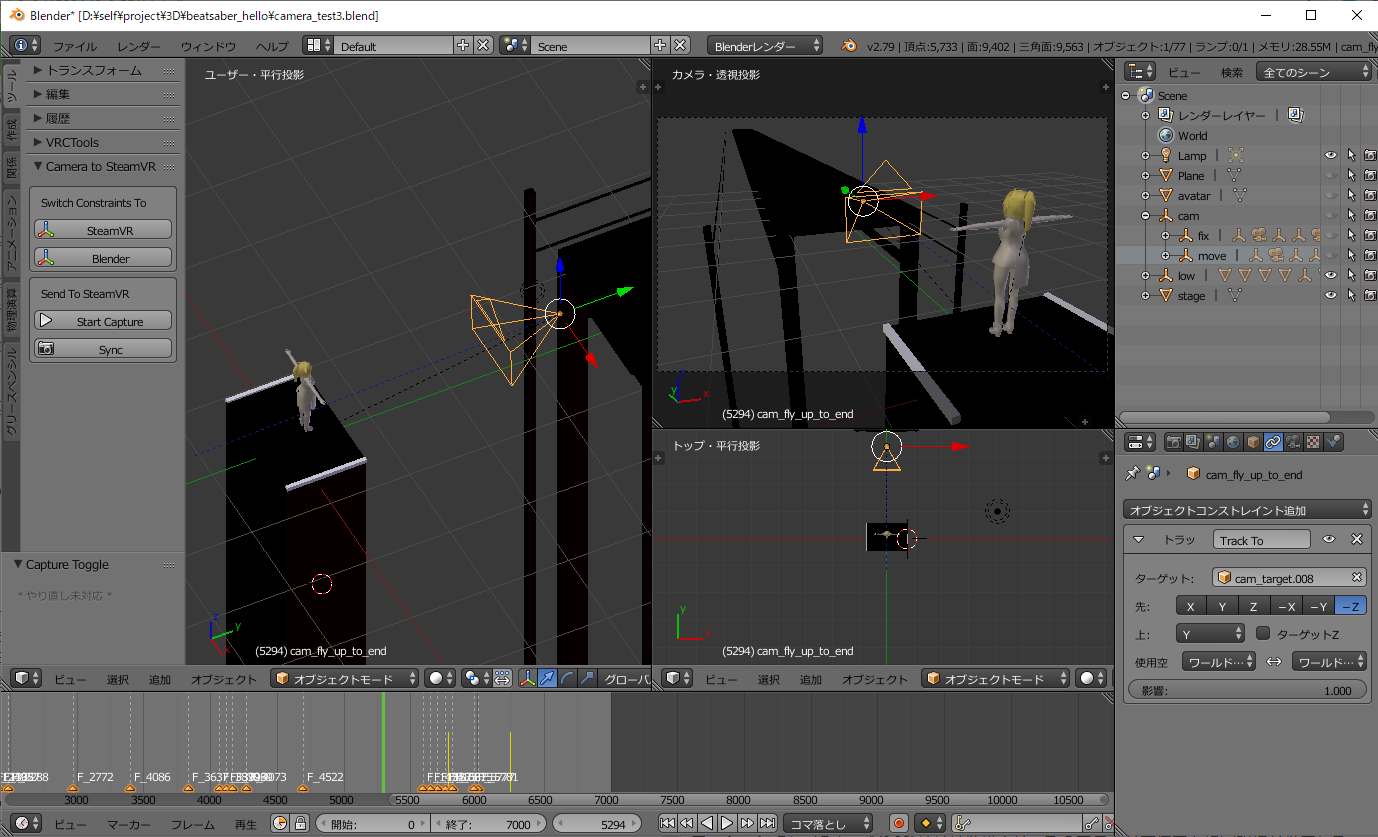

カメラを動かしたいのですが3Dの座標の計算がよくわからないので、Blenderのカメラ位置をそのまま共有メモリに書き込むアドオンとして作りました。

Blender上で何もないとどこをカメラで狙えばいいかわからないので適当にアバターやステージを置きました。

実際に撮れる動画と比べるとどうしてもズレるのであくまでも目安です。フレームが変わるタイミングかsyncボタンを押すと、シーンでアクティブなカメラの位置と回転を仮想コントローラーへ送ることができます。

SteamVRとBlenderで座標の向きが違うようで、揃えるために入れ替えたりしてみたらカメラの方向がおかしくなってしまいました・・・。

多分ちゃんと計算すればいいのですが手動で切り替えることで無理やり動かしてます。

(カメラの回転の向きをTrack Toコンストレイントで決めていて、そこのプロパティを変更することで向きを変えている)blender_to_SteamVR.pyimport bpy import mmap bl_info = { "name" : "camera move test", "author" : "imakami", "version" : (0,1), "blender" : (2, 7, 0), "location" : "", "description" : "", "warning" : "", "wiki_url" : "", "tracker_url" : "", "category" : "" } capture = False shareMem = False class AnimationCaptureToggle(bpy.types.Operator): bl_idname = "imakami.animation" bl_label = "Capture Toggle" bl_description = "Start Capture" bl_options = {'REGISTER', 'UNDO'} def invoke(self, context, event): global capture if capture == False: bpy.app.handlers.frame_change_pre.append(sendCameraPos) capture = True else: bpy.app.handlers.frame_change_pre.clear() capture = False return {'FINISHED'} class CameraSync(bpy.types.Operator): bl_idname = "imakami.camera" bl_label = "Sync" bl_description = "Sync" bl_options = {'REGISTER', 'UNDO'} def invoke(self, context, event): sendCameraPos(self) return {'FINISHED'} def sendCameraPos(self): global shareMem if shareMem == False: shareMem = mmap.mmap(0,16384,'pip1') nowCameraPos, nowCameraRotate, nowCameraScale = bpy.context.scene.camera.matrix_world.decompose() #scaleは使ってない posX = str(nowCameraPos[0]) #XAxis posY = str(nowCameraPos[2]) #ZAxis posZ = str(nowCameraPos[1]*-1) #YAxis rotQuat = [] for i in range(4): if i == 2: rotQuat.append(str(nowCameraRotate[i]*-1)) else: rotQuat.append(str(nowCameraRotate[i])) shareMem.seek(0) wait = shareMem.read(1) if wait != b'x': print('not wait') return shareMem.seek(0) shareMem.write(b'{"id":0,"v":['+posX.encode()+b','+posY.encode()+b','+posZ.encode()+b'],"vd":[0,0,0],"vdd":[0,0,0],"r":['\ +rotQuat[0].encode()+b','+rotQuat[1].encode()+b','+rotQuat[3].encode()+b','+rotQuat[2].encode()\ +b'],"rd":[0,0,0],"rdd":[0,0,0],"Valid":true}') #print(posX,posY,posZ) class TransToVRCameraAxis(bpy.types.Operator): bl_idname = "imakami.to_vr" bl_label = "SteamVR" bl_description = "Switch Constraints To SteamVR" bl_options = {'REGISTER', 'UNDO'} def invoke(self, context, event): changeCameraTrackAxis('TRACK_Y','UP_Z') return {'FINISHED'} class TransToBlenderCameraAxis(bpy.types.Operator): bl_idname = "imakami.to_bl" bl_label = "Blender" bl_description = "Switch Constraints To Blender" bl_options = {'REGISTER', 'UNDO'} def invoke(self, context, event): changeCameraTrackAxis('TRACK_NEGATIVE_Z','UP_Y') return {'FINISHED'} def changeCameraTrackAxis(trackAxis, upAxis): for obj in bpy.data.objects: if obj.type == 'CAMERA': track = obj.constraints.get('Track To') if track != None: track.track_axis = trackAxis track.up_axis = upAxis class addonPanel(bpy.types.Panel): bl_label = "Camera to SteamVR" bl_space_type = "VIEW_3D" bl_region_type = "TOOLS" bl_category = "Tools" def draw(self, context): global capture sc = context.scene layout = self.layout boxAxis = layout.box() boxAxis.label(text = "Switch Constraints To") boxAxis.operator(TransToVRCameraAxis.bl_idname, icon="MANIPUL") boxAxis.operator(TransToBlenderCameraAxis.bl_idname, icon="MANIPUL") boxCap = layout.box() boxCap.label(text = "Send To SteamVR") if capture == False: boxCap.operator(AnimationCaptureToggle.bl_idname, text="Start Capture", icon="PLAY") else: boxCap.operator(AnimationCaptureToggle.bl_idname, text="Stop",icon="REC") boxCap.operator(CameraSync.bl_idname, icon="SCENE") classes = {TransToVRCameraAxis,TransToBlenderCameraAxis,AnimationCaptureToggle,CameraSync,addonPanel} def register(): for cls in classes: bpy.utils.register_class(cls) def unregister(): for cls in classes: bpy.utils.unregister_class(cls) if __name__ == "__main__": register()これでBlender上でアニメーションを再生すると、アクティブなカメラの位置と連動して仮想コントローラーが動くようになりました。

後はLIVでこの仮想コントローラーをカメラに指定して、バーチャルモーションキャプチャーとLIVで読み込むexternalcamera.cfgのx/y/z/rx/ry/rzを全て0にしたファイルを読み込ませるようにします。

そうして書いたBlenderアドオンとgpsnmeajp氏の書いたコントローラードライバのサンプルコードをそのまま使って以下の動画を撮りました。最新版のバーチャルモーションキャプチャーが軽いのでかなり無茶なことができるようになった

— いまかみ (@imakami) 2019年6月27日

Song:Hello by Capsule

Custom Map : Firm Retention#バーチャルモーションキャプチャー #BeatSaber pic.twitter.com/mqUXk0pJiuまとめ

この手法だと対象となるゲームとLIVとバーチャルモーションキャプチャーとOBSとBlenderを同時に動作させないといけません。

LIVとバーチャルモーションキャプチャーの処理が結構重くてカクカクになったりしていたのですが、最新版のバーチャルモーションキャプチャー(V0.32)がかなり軽くなったのでこんな方法でも現実的になりました。

とはいえBeat Saberで最低のグラフィック設定にしたケースでの話です。自分のPC(CPU i7 4770 グラボ GTX1060)だと720pでギリギリでフルHDだと無理な感じです。仮想コントローラーが手に持つコントローラと認識されるということがありました。コントローラの電源を入れなおしたりすると直ったりします。

バーチャルモーションキャプチャーの設定も手動で各コントローラーを指定するとうまく動くようになりました。動画を撮る際、Blenderで普通に動画を作成するようにカメラ切り替えとアニメーションを前もってすべて作成するというめちゃくちゃ面倒なことをしています。

コントローラーを移動させたい座標とクォータニオンでの回転を共有メモリに書き込むだけなのでBlender抜きでコードを書いて、適当なボタンを押すとカメラが動くとかにした方が使いやすいと思われます。

- 投稿日:2019-06-27T23:01:09+09:00

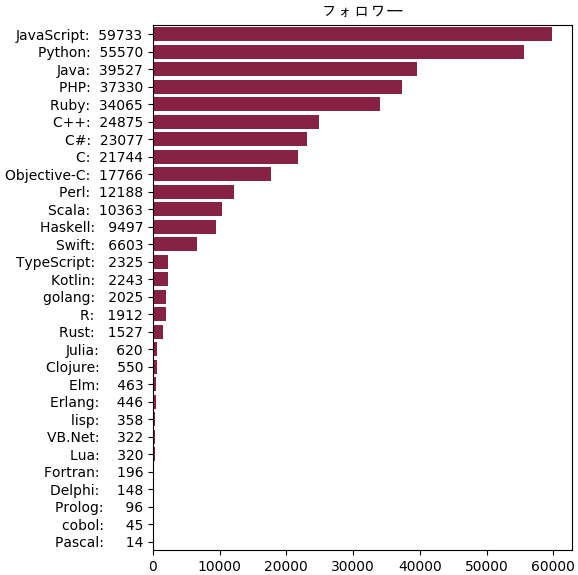

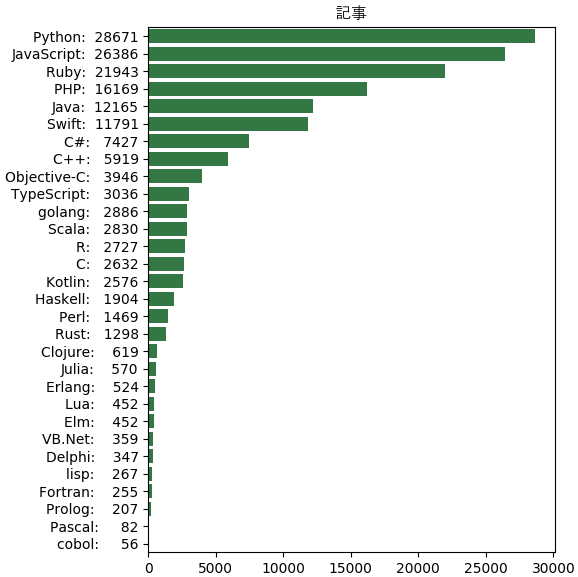

QiitaAPIで各プログラミング言語のタグの記事とフォロワーの数を調べて纏めたりする(pythonとrubyを使う)

今どのプログラミング言語がどれくらい人気なのか気になるので、qiitaで書かれた記事のタグを調べて見ましたが、一々調べるよりもコードを書いてQiitaAPIからデータを取得して分析する方が楽なので、書いてみました。この記事では試してみたこととその結果を纏めてみます。

QiitaAPIについて

QiitaAPIにアクセスしたらタグの記事の数とフォローしている人数を調べることができます。

例えばc++のタグ https://qiita.com/api/v2/tags/c++

QiitaAPIについて詳しくは https://qiita.com/api/v2/docs

このようなjsonデータが出ます

{"followers_count":24875,"icon_url":"https://s3-ap-northeast-1.amazonaws.com/qiita-tag-image/fe7df47710bdae8b8565b323841a6b89e2f66b89/medium.jpg?1515774066","id":"C++","items_count":5919}使うプログラミング言語

基本的にQiitaAPIのようなAPIは色んな言語で簡単に扱えるようですが、今回はrubyとpythonを使ってQiitaAPIを通じて色んなプログラミング言語のタグの記事とフォロワーの数を調べて纏めてみます。

最初は全部rubyでやってみたいと思っていたのですが、データの分析やグラフを描くことがやはりpythonのpandasとmatplotlibを使ったほうがずっと楽です。

なのでrubyでデータをcsvに保存して、pythonでグラフを描くという形になります。

ここで挙げるのは自分が知っている言語だけです。それ以外知らない言語もあるかもしれないです。その他に、私の知っている言語の中にも IDLなどqiitaで全然記事が見つからない言語もあります。

プログラミング言語だけ比べるので、htmlやxmlみたいなマークアップ言語や、cssみたいなスタイルシート言語などは含まれません。

rubyでタグのデータをcsvに保存する

rubyでは標準モジュールとしてopen-uriというスクレイピング用のモジュールがあるので、簡単にQiitaAPIからデータを取得できます。

csvの扱いも簡単にcsvモジュールが使えます。これも標準モジュールなので個別にインストールする必要がありません。

require "open-uri" require "json" require "csv" gengo = %w!c c++ csharp cobol clojure delphi elm erlang fortran golang haskell java javascript julia kotlin lisp lua objective-c pascal perl php prolog python r ruby rust scala swift typescript vb.net! col = %w!id items_count followers_count! CSV.open('qiitaprogramming.csv','w'){|csv| gengo.each{|gg| data = JSON.parse(open('https://qiita.com/api/v2/tags/'+gg).read) csv << col.map{|c|data[c]} } }こういうcsvファイルが出来ます。左の方が記事の数で、右の方がフォロワーの数です。

C,2632,21744 C++,5919,24875 C#,7427,23077 cobol,56,45 Clojure,619,550 Delphi,347,148 Elm,452,463 Erlang,524,446 Fortran,255,196 golang,2886,2025 Haskell,1904,9497 Java,12165,39527 JavaScript,26386,59733 Julia,570,620 Kotlin,2576,2243 lisp,267,358 Lua,452,320 Objective-C,3946,17766 Pascal,82,14 Perl,1469,12188 PHP,16169,37330 Prolog,207,96 Python,28671,55570 R,2727,1912 Ruby,21943,34065 Rust,1298,1527 Scala,2830,10363 Swift,11791,6603 TypeScript,3036,2325 VB.Net,359,322pythonでデータを並べて棒グラフを描く

pythonにもスクレイピング用のモジュールがたくさんあります。ここではrequestsというモジュールを使います。

データを数によって並べるにはpandasでは一番やりやすいです。

グラフを描くにはmatplotlibが一番です。

どれでも標準モジュールではないからインストールする必要がありますが、anacondaとか使っていたら最初から含まれているはずです。

pip install requests pandas matplotlibちなみに、rubyにもdaruというpandasと似ているモジュールが存在します。https://github.com/SciRuby/daru/wiki/pandas-vs-daru

import requests import matplotlib.pyplot as plt import pandas as pd lis_tagid = '''c c++ csharp cobol clojure delphi elm erlang fortran golang haskell java javascript julia kotlin lisp lua objective-c pascal perl php prolog python r ruby rust scala swift typescript vb.net '''.split() gengo = [] n_follow = [] n_item = [] for tagid in lis_tagid: r = requests.get('https://qiita.com/api/v2/tags/'+tagid) r.raise_for_status() data = r.json() gengo.append(data['id']) n_follow.append(data['followers_count']) n_item.append(data['items_count']) df = pd.DataFrame(index=gengo) df['記事'] = n_item df['フォロワー'] = n_follow print(df) y = range(len(df)) plt.figure(figsize=[6,6]) plt.gca(ylim=[min(y)-0.5,max(y)+0.5]) df.sort_values('フォロワー',inplace=True) plt.yticks(y,['%s: %6s'%x for x in df['フォロワー'].iteritems()]) plt.barh(y,df['フォロワー'],color='#882244') plt.title(u'フォロワㄧ',family='AppleGothic') plt.tight_layout() plt.figure(figsize=[6,6]) plt.gca(ylim=[min(y)-0.5,max(y)+0.5]) df.sort_values('記事',inplace=True) plt.yticks(y,['%s: %6s'%x for x in df['記事'].iteritems()]) plt.barh(y,df['記事'],color='#337744') plt.title(u'記事',family='AppleGothic') plt.tight_layout() plt.show()結果

記事 フォロワー C 2632 21744 C++ 5919 24875 C# 7427 23077 cobol 56 45 Clojure 619 550 Delphi 347 148 Elm 452 463 Erlang 524 446 Fortran 255 196 golang 2886 2025 Haskell 1904 9497 Java 12165 39527 JavaScript 26386 59733 Julia 570 620 Kotlin 2576 2243 lisp 267 358 Lua 452 320 Objective-C 3946 17766 Pascal 82 14 Perl 1469 12188 PHP 16169 37330 Prolog 207 96 Python 28671 55570 R 2727 1912 Ruby 21943 34065 Rust 1298 1527 Scala 2830 10363 Swift 11791 6603 TypeScript 3036 2325 VB.Net 359 322纏め

結果から見ると、フォロワーの数はjavascriptの方が一番ですが、記事の数はpythonの方が一番です。

javascriptはウェブ開発に欠かせない言語ですし、データサイエンスや機械学習のおかげでこの数年の間にpythonはどんどん人気な言語になってきたようです。

二年前のこの記事を調べてみたら https://qiita.com/ty-edelweiss/items/b8172c2e22726bc08aeb

あの時pythonの記事はrubyよりも少なかったようです。javaとphpとrubyもその次に人気のようです。

C言語などはフォロワーが多い割には記事が少ないです。

結果としてフォロワーと記事の数を見ると、この数年間のプログラミング言語の使う傾向をある程度示せるはずです。

編集: 2019年6月28日に、Rustを追加しました

- 投稿日:2019-06-27T22:34:45+09:00

Python bool() の中で何が起こっているか

組み込み関数の1つ、

bool()

引数として渡されたオブジェクトの真偽値を返却します。中で何が起こっているか確認する

オブジェクトの真偽値はどうやって決まるのでしょうか?

公式リファレンスによると

https://docs.python.org/ja/3/library/stdtypes.html#truthオブジェクトは、デフォルトでは真と判定されます。ただしそのクラスが

__bool__()メソッドを定義していて、それが False を返す場合、または__len__()メソッドを定義していて、それが 0 を返す場合は偽と判定されます。だそうです。試してみます。

# __bool__() __len__()を定義している場合 >>> class Class1: ... def __bool__(self): ... print('__bool__が呼ばれたよ') ... return False ... def __len__(self): ... print('__len__が呼ばれたよ') ... return 0 ... >>> hoge = Class1() >>> bool(hoge) __bool__が呼ばれたよ False # __bool__()が定義されていない場合 >>> class Class2: ... def __len__(self): ... print('__len__が呼ばれたよ') ... return 0 ... >>> piyo = Class2() >>> bool(piyo) __len__が呼ばれたよ False # __bool__()__len__()が定義されていない場合 >>> class Class3(): ... pass >>> fuga = Class3() # デフォルトどおり真が返る >>> bool(fuga) True応用してみる

組み込み型のクラスであれば

__bool__()か__len__()のどちらかは定義されています。

組み込み型を継承して自作クラスをつくる場合はこれらの特殊メソッドをオーバーライドできます。

例えば↓こんな感じ# 通常のリストの場合、要素が1つ以上あれば真になる >>> list = list([0]) >>> bool(list) True # 要素それぞれの真偽値判定をし、真になるものが1つ以上あれば真を返す >>> class MyList(list): ... def __bool__(self): ... return any(self) ... >>> my_list = MyList([0]) >>> bool(my_list) False

bool()の中で何が起こっているか理解していると、こういったアレンジができちゃいます。

(特殊メソッドをオーバーライドすると影響範囲が大きくなるので、やるときは慎重に!)

- 投稿日:2019-06-27T22:03:53+09:00

【後編】KaggleのKarnel上でtitanic問題を解いてみた ~モデル作成~

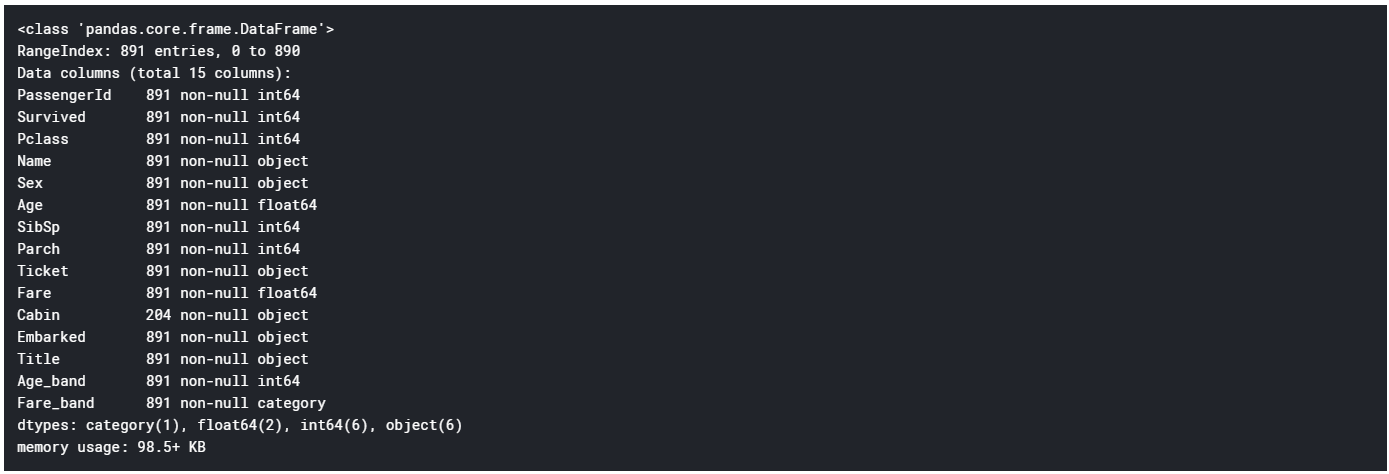

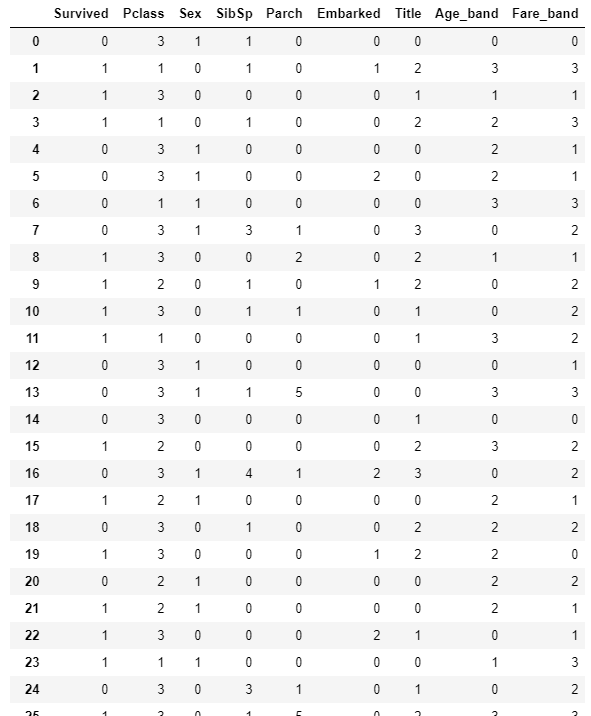

前回の続き。今回は実際に予測モデルの構築、kaggleへのサブミットまでを行う。

動作環境

・Kaggle kernel上

準備

ライブラリのインポート

import numpy as np import pandas as pd import matplotlib.pyplot as plt %matplotlib inline import seaborn as sns import plotly.offline as py import plotly.graph_objs as go import cufflinks as cf py.init_notebook_mode(connected=True) # デフォルトでPlotlyがオンラインモードになっているので、オフラインモードへと変更 #cf.go_offline()# 恒久的にデフォルトをオフラインモードにデータセットの読み込み

train=pd.read_csv("../input/train.csv") test=pd.read_csv("../input/test.csv") data=[train,test]前処理

どう前処理するか

・欠損値を何らかの形で埋める

・不必要と思しきデータを排除する

・連続した数字データをカテゴライズ

(例えば、0~99までの数字を含むデータをそのまま扱うと100クラスに区別されたことになり、大雑把に多い、少ないを把握できない)

・文字データを数字におきかえる(分類器は数字しか受け付けない)

分類器につっこむ前に上記の処理が必要...具体的には....

欠損値を数えた結果、欠損しているのはAge, Cabin, Embarked。

●Cabinは891人中687人のデータが欠損しているので、あんまり使えなさそう

●Embarkedが欠損しているのは高々2名分なので、これはそれほど影響はなさそう。

●Name・・・生死には関係ないと思われる。ただし、Mr.やMrs.などの敬称は人物の属性を表すので関係あるかも。

●PassengerId・・・通し番号なので、関係が薄いと思われる。(断言はできないが)今回は排除。

●ticket・・・分類器には数字化したデータしか用いることができないことを考えると、規則性がわからない文字列に頼るのはあまり得策ではなさそう。使用する分類器

今回は、ランダムフォレストによって、予測モデルを構築する。

そのため、ゴールとしてはrandom forest classifierに突っ込むことだが、分類器は基本的には数字のデータにしておかなければいけない。

今回のデータセットの意味を考えると、氏名が生死に影響するとは考えにくい。

しかし、"Name"にはすべて、"Mr"や"Mrs"といった敬称が含まれており、これはその人の属性を表すものとして、結果に影響を与えそうである。(性別や年齢のセグメントで敬称が変わるため)

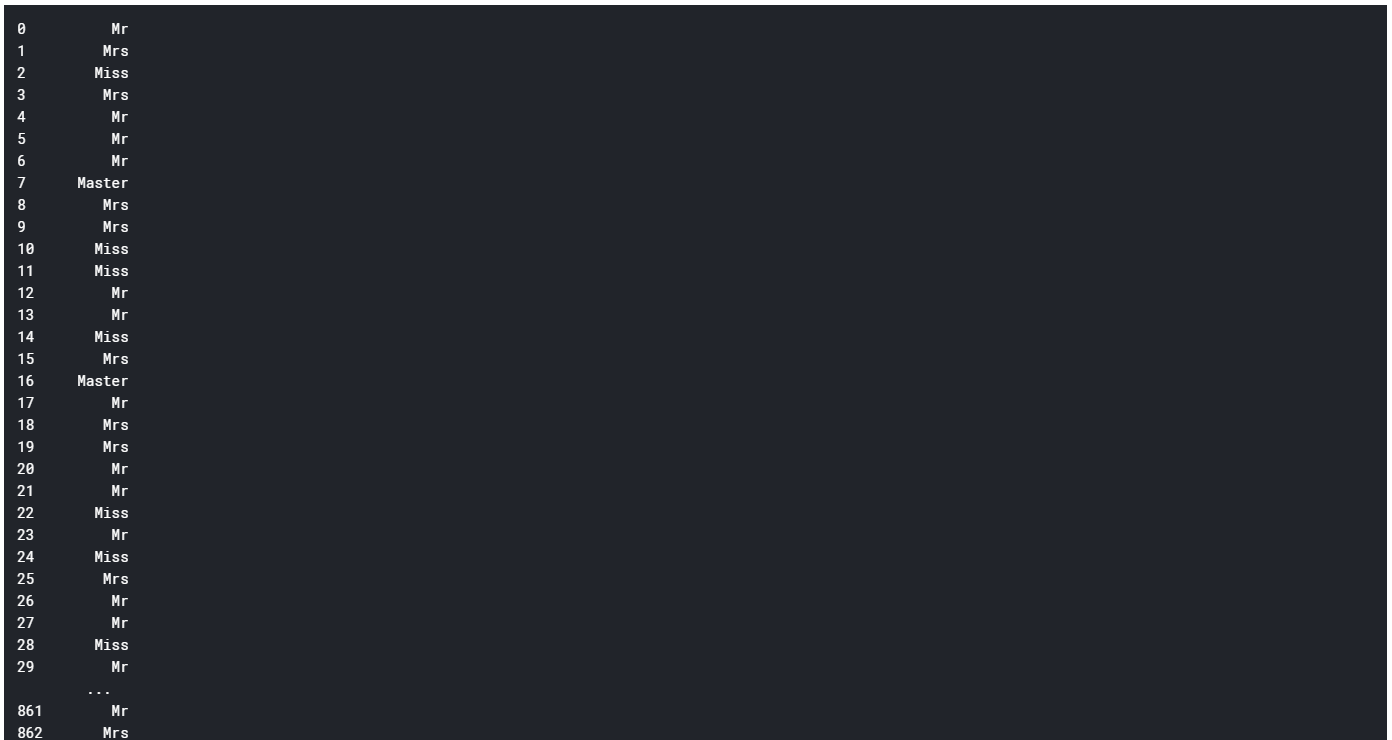

そこで、"Name"から全員分の敬称を抜き出すことを考える。敬称は多岐に渡るようであるから、いくつかのパターンに分類する。名前は敬称だけ抜き取る

import re def get_title(name): title_search = re.search(' ([A-Za-z]+)\.', name) if title_search: return title_search.group(1) return "" #"Title"という列を作り、その中に全員分の敬称を収録する for df in [train,test]: df['Title'] = df['Name'].apply(get_title)train.info() #確認train.Title#trainに対して train.Title.value_counts()#testに対して test.Title.value_counts()#Mr, Miss, Others(その他)におきかえ for df in data: df['Title'] = df['Title'].replace(['Lady', 'Countess','Capt', 'Col','Don', 'Dr', 'Major', 'Rev', 'Sir', 'Jonkheer', 'Dona'], 'Others') df['Title'] = df['Title'].replace(["Mlle","Ms"],"Miss") df['Title'] = df['Title'].replace("Mme","Mrs")train.Title.value_counts() #改めて、どの敬称がいくつずつ含まれているのかを調べる欠損値を埋める

train.isnull().sum() #改めてtrain、testそれぞれについて各列における欠損値の個数を確認test.isnull().sum()欠損しているのは

●trainについて・・・Embarked、Age、Cabinの3種類

●testについて・・・Fare、Age、Cabinの3種類まずはtrainのembarkedから埋めていく。

欠けているのは高々二人分なので、一番乗ってきた人が多い港で補完する。

train.Embarked.value_counts() #train.Embarkedの値とその個数を一覧にして表示するtrain.Embarked=train.Embarked.fillna("S") #"S"が最も多かったので、欠損値に"S"を代入train.Embarked.value_counts() #確認するAgeを補完する。(train,test両方)

一番荒っぽいが手っ取り早い方法は、 全ての年齢の欠損値を「年齢のデータが残っている乗客の平均年齢」で埋めてしまうことである。 しかし、これでは若干雑すぎるので「敬称ごとの平均で埋める」という方法を採用する。 敬称の区別は年齢の情報を含んだものであると考えられるため、有効だと思われる。

敬称別での年齢の平均をとって、欠損値を埋めよう。 for文を用いることで、train、test両方に対して一気に処理をしてしまおう。

for df in data: for title in train.Title.unique(): df.loc[(df.Age.isnull())&(df.Title==title),"Age"] = df.loc[df.Title==title,'Age'].mean() #unique()は重複しない値をリストにして返すpandasの関数#参考 df.loc[df.Title=='Mr','Age'].mean()#参考unique関数 train.Title.unique()testのFareが1箇所欠けているので、これを埋める

高々1箇所なので、testの他のFare列の中央値を入れてしまえば十分。

#testのFareを埋める test.Fare=test.Fare.fillna(test.Fare.median())残るはCabinの情報だが・・・

Cabinは欠損値の方が多いため、今回はCabinの情報は使えないものと判断し、あとで丸ごと削除することとする。

これでCabin以外の欠損値はすべて補完できたはずである。

念のため確認を行う。train.isnull().sum()test.isnull().sum()データのカテゴリ化

バラバラの値をとるデータをカテゴリ化する。

運賃の額(Fare)と、年齢(Age)のデータはそれぞれバラバラの値をとっているが、分類器にデータを投入することを考えると、これらのデータをカテゴリ化しておく必要がある。

分類器は数字のみ受け付けるため、カテゴリ名には数字を割り当てることとするが、分類器はfloat型(浮動小数)には対応しないため、必ずint型に整形しておく必要があることに注意。for df in data:#train,testともに適用 # "Age"を5クラスにわけ、"Age_band"列を新たに作り、クラスの値を代入 df.loc[ df['Age'] <= 22, 'Age_band'] = 0 df.loc[(df['Age'] > 22) & (df['Age'] <= 30), 'Age_band'] = 1 df.loc[(df['Age'] > 30) & (df['Age'] <= 37), 'Age_band'] = 2 df.loc[(df['Age'] > 37) & (df['Age'] <= 59), 'Age_band'] = 3 df.loc[ df['Age'] > 59, 'Age_band'] = 4 df.Age_band = df.Age_band.astype(int)''' for df in data: # "Fare"を4クラスにわけ、"Fare_band"列を新たに作り、クラスの値を代入 df.loc[ df['Fare'] <= 8, 'Fare_band'] = 0. df.loc[(df['Fare'] > 8) & (df['Fare'] <= 15), 'Fare_band'] = 1 df.loc[(df['Fare'] > 15) & (df['Fare'] <= 31), 'Fare_band'] = 2 df.loc[ df['Fare'] > 31, 'Fare_band'] = 3 df.Fare_band = df.Fare_band.astype(int) ''' #上の方法でもよいがここではqcutを用いた手法を用いる for df in data: df['Fare_band']=pd.qcut(df.Fare,4,labels=range(4))少し寄り道

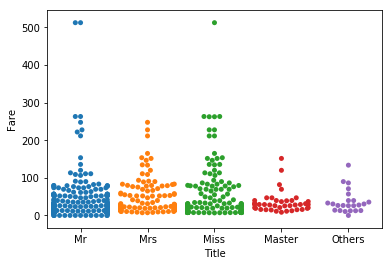

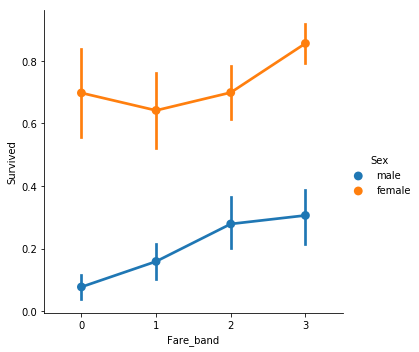

新しい列Title,Age_band,Fare_bandを作ったことで

新たな切り口でデータを視覚化することが可能になった。

ここで、Title、Age_band、Fare_bandを切り口としていくつかグラフを作成する。敬称(Title)と支払った運賃(Fare)の関係を調べて視覚化してみよう。

sns.swarmplot("Title","Fare",data=train) #敬称(Title)と支払った運賃(Fare)の関係運賃のクラス(Fare_band)と性別(Sex)で生存率がどう変わるかを調べよう。

sns.factorplot("Fare_band","Survived",data=train,hue="Sex") #運賃のクラス(Fare_band)・性別(Sex)と生存率の関係不要と思しきデータの削除

・PassengerId・・・形式が扱いにくい(クラス分類しにくい)上に、あまり生死と関係がなさそう

・Name・・・敬称を集めたTitle列を作ったので用済み

・Ticket・・・規則性が見出せず扱いに困る

・Cabin・・・欠損値が多すぎるので不採用

・Age・・・Age_bandを作ったので用済み

・Fare・・・Fare_bandを作ったので用済みdrop_columns = ['PassengerId', 'Name', 'Ticket', 'Cabin','Age','Fare'] # 上の6つのcolumn名をリストに。train.info()train = train.drop(drop_columns, axis = 1) test = test.drop(drop_columns, axis = 1) ''' for df in data: df=df.drop(drop_columns,axis=1) '''データをすべて数字になおす

いま文字列の形で記述されているのは

・Sex列

・Title列

・Embarked列

である。いずれもカテゴリであるので、ラベルとして数字を割り当ててあげればよい。

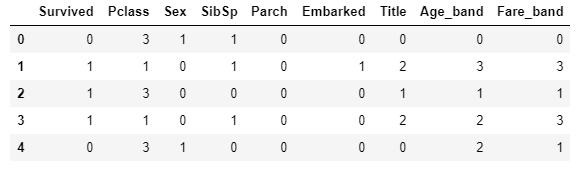

(例) Mr:0, Miss:1, Mrs:2 ・・・などdata=[train,test]#for文でdropした場合には不要 for df in data: # 性別を数字でおきかえ df.loc[df['Sex']=="female", "Sex"]=0 df.loc[df['Sex']=='male','Sex']=1 # 敬称を数字で置き換え df.loc[df['Title']=='Mr', 'Title']=0 df.loc[df['Title']=='Miss', 'Title']=1 df.loc[df['Title']=='Mrs', 'Title']=2 df.loc[df['Title']=='Master', 'Title']=3 df.loc[df['Title']=='Others', 'Title']=4 # 乗船した港3種類を数字でおきかえ df.loc[df['Embarked']=='S', 'Embarked']=0 df.loc[df['Embarked']=='C', 'Embarked']=1 df.loc[df['Embarked']=='Q', 'Embarked']=2train #データの確認データを分類器につっこむ

from sklearn.model_selection import train_test_splittrain.head()test.head()testのデータには答え("Survived")がついておらず、これを用いて学習器の良し悪しを確かめる術がないので、

trainの一部のデータを分類器の検証用に用いることとする。train→tr_train、tr_test に分割

(tr_trainデータ数):(tr_testのデータ数)=7:3

となるように指定する。tr_train,tr_test=train_test_split(train, test_size=0.3) #tr_train,tr_testに振り分けられるデータはランダムに決まるprint(tr_train.info()) print(tr_test.info())tr_train_Xにはtr_trainの"Survived"列【以外】のデータを、

tr_train_Yにはtr_trainの"Survived"列のみを、

tr_test_Xにはtr_testの"Survived"列【以外】のデータを、

tr_test_Yにはtr_testの"Survived"列のみを納める。tr_train_X = tr_train[train.columns[1:]] tr_train_Y = tr_train[train.columns[0]] tr_test_X = tr_test[train.columns[1:]] tr_test_Y = tr_test[train.columns[0]]決定木(DecisionTreeClassifier)

決定木のモデルを設定。from sklearn.tree import DecisionTreeClassifier model=DecisionTreeClassifier()このモデルにtr_train_Xのデータを学習させ、tr_train_Yのデータを分類し判別率を算出

model.fit(tr_train_X,tr_train_Y) predict= model.predict(tr_test_X)判別率をsklearn.metricsを用いて見てみる

from sklearn import metrics print('判別率:',metrics.accuracy_score(predict, tr_test_Y))ランダムフォレスト(RandomForestClassifier)

ランダムフォレストのモデルを設定。とりあえず、n_estimatorは100としておく。from sklearn.ensemble import RandomForestClassifier model=RandomForestClassifier(n_estimators=100)このモデルにtr_train_Xのデータを学習させ、tr_train_Yのデータを分類し判別率を算出

model.fit(tr_train_X,tr_train_Y) predict= model.predict(tr_test_X)判別率をsklearn.metricsで確認

from sklearn import metrics print('判別率:',metrics.accuracy_score(predict, tr_test_Y))K-分割交差検証

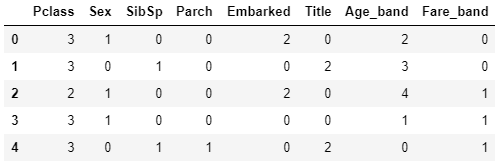

from sklearn.model_selection import KFold, cross_val_score, cross_val_predict kf=KFold(n_splits=5, random_state=30, shuffle=True) x=train[train.columns[1:]] y=train["Survived"] cv_result = cross_val_score(model, x, y, cv = kf) print(cv_result) print("平均精度:{}".format(cv_result.mean()))グリッドサーチ

ハイパーパラメータチューニングの最も基本的な手法

from sklearn.model_selection import GridSearchCV param={'n_estimators':range(100,1000,100),"max_depth":range(1, 10, 1)}#100から1000の100区切り GS_rf=GridSearchCV(estimator=RandomForestClassifier(random_state=0),param_grid=param,verbose=True,cv=5) GS_rf.fit(x,y) print(GS_rf.best_score_) print(GS_rf.best_estimator_)ランダムフォレストのパラメタチューニングの結果、試した条件の中では、

決定木の数:200

が最適で、このとき

精度:約81%

の分類器が得られることがわかった。補足:GridSearchCVはパラメタチューニングを行う際、引数cvをn(整数)と設定すれば

どのパラメタの組み合わせが「最適」であるかを求めるために、裏でデータをn分割して交差検証を行ってくれる。testこれまではtrainデータセットの一部を精度予測のテスト用に用いていたが、最後はtrainデータセット全てで学習を行う。

前準備として、

train_Xにはtrainの"Survived"列【以外】のデータを、

train_Yにはtrainの"Survived"列のみを、格納する。train_X=train[train.columns[1:]] train_Y=train[train.columns[0]]test用のデータセット(test.csv)をこのモデルに従って分類。

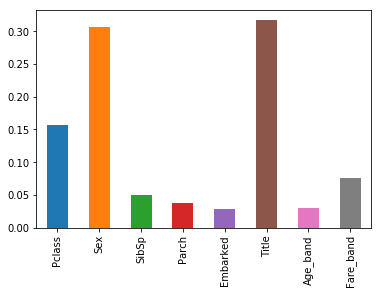

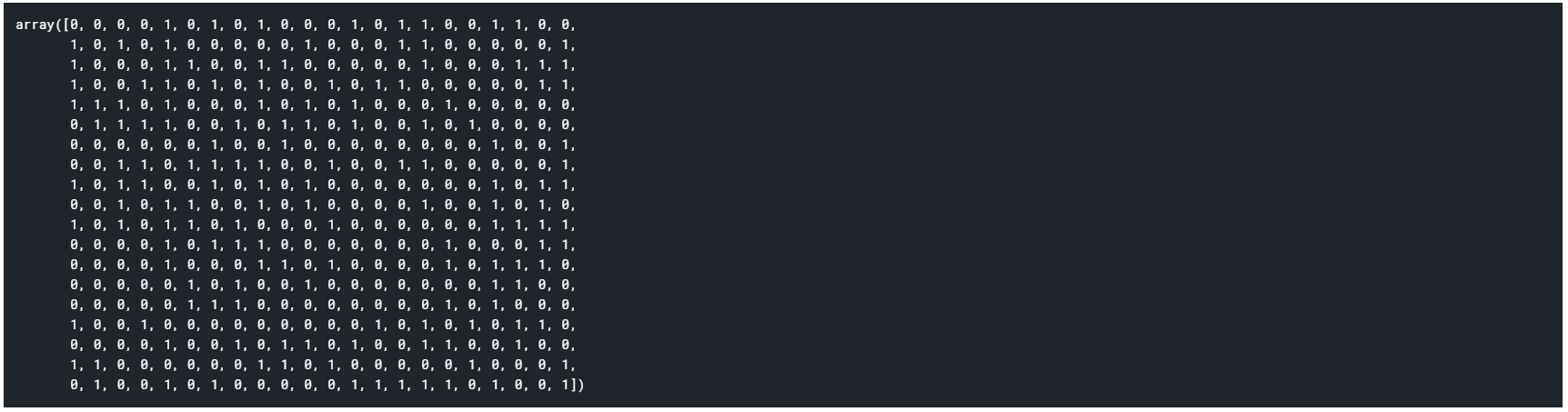

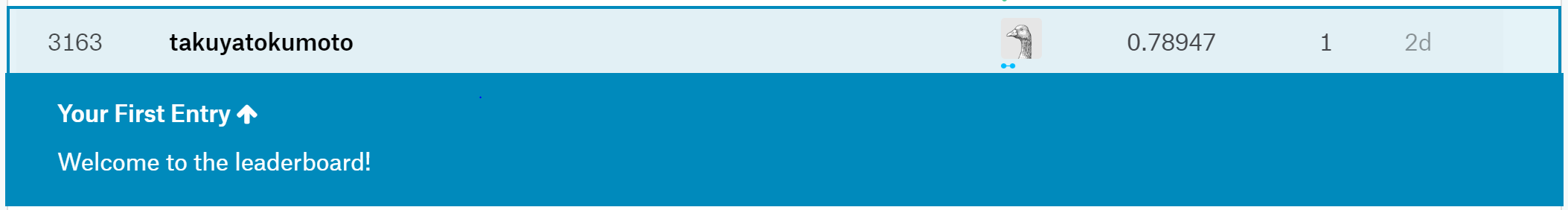

また、分類結果を提出する形式にまとめる(csv形式)model=RandomForestClassifier(max_depth=4, n_estimators=200) model.fit(train_X,train_Y)test_prediction = model.predict(test) passenger_id = np.arange(892,1310) test = pd.DataFrame( { 'PassengerId': passenger_id , 'Survived': test_prediction } ) test.shape test.head() test.to_csv( 'titanic_forsubmisson.csv' , index = False )pd.Series(model.feature_importances_, index=tr_train_X.columns).plot.bar()test_prediction# PassengerIdを取得 PassengerId = np.array(test["PassengerId"]).astype(int) # my_prediction(予測データ)とPassengerIdをデータフレームへ落とし込む my_solution = pd.DataFrame(test_prediction, PassengerId, columns = ["Survived"]) # my_tree_one.csvとして書き出し my_solution.to_csv("my_tree_one.csv", index_label = ["PassengerId"])最終結果

- 投稿日:2019-06-27T21:57:29+09:00

量子アルゴリズムの基本:算術演算の確認(加算)

$$

\def\bra#1{\mathinner{\left\langle{#1}\right|}}

\def\ket#1{\mathinner{\left|{#1}\right\rangle}}

\def\braket#1#2{\mathinner{\left\langle{#1}\middle|#2\right\rangle}}

$$はじめに

前々回の記事で「量子フーリエ変換」、前回の記事で「位相推定アルゴリズム」の確認ができたので、次は「Shorのアルゴリズム」と思っていたら、「べき剰余」も必要なのでした。で、べき剰余を実行するためには、いくつかの算術演算の基礎も必要ということなので、以後しばらくは、算術演算を順に確認していこうと思います。今回はもっとも簡単な「加算」です。アルゴリズムを説明した後、自作の量子計算シミュレータqlazyで、動作の確認をします。

参考にさせていただいた論文・記事は以下の通りです。

- V. Vedral,A. Barenco,A. Ekert; "Quantum Networks for Elementary Arithmetic Operations" (arXiv:quant-ph/9511018)

- 量子コンピュータ(シミュレータ)でモジュール化可能な加算器を作る

加算の実現方法

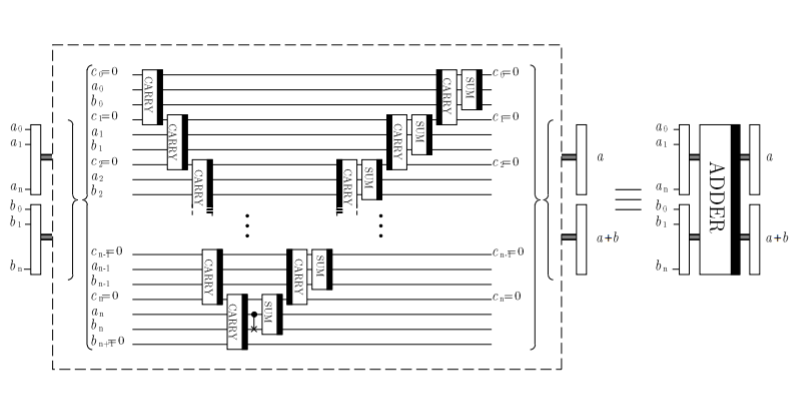

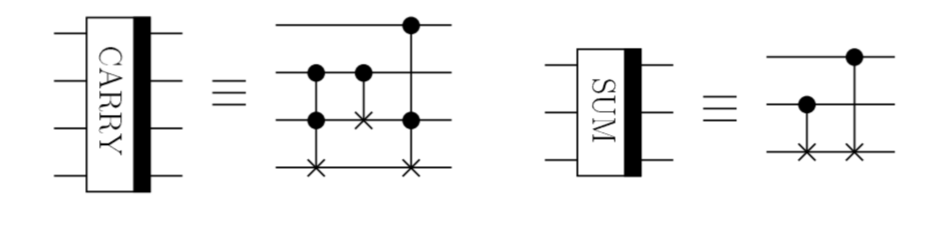

参考論文に全体の回路図が出ているので、まずそれを掲載します。

論文には、

\ket{a,b} \rightarrow \ket{a,a+b}を計算する回路と説明されています。ここで、$a_0,a_1,...$と$b_0,b_1,...$は、整数$a,b$を2進数で表したときの各桁の値{0,1}を下の桁から順に並べた数列です。$c_0,c_1,...$は、各桁を加算したときに発生する桁上げ情報を格納するための補助量子ビットです。また、CARRYとSUMと書いてあるボックスは各々以下のような量子回路で定義されます。

これで本当に加算が実現できるのでしょうか。まずは各部品(CARRYとSUM)の動作から地道に見ていくことにします。

CARRYの動作

CARRYの量子レジスタは4つあり、1つのCNOTゲートと2つのToffoliゲートから構成されています。入力状態を上から$\ket{x},\ket{y},\ket{z},\ket{w}$としたとき、最初のToffoliゲート、CNOTゲート、2番目のToffoliゲートを通っていくに従い、どのように状態が変化するかを以下の表に示してみます。

初期状態 Toffoli[1] CNOT Toffoli[2] $x$ $x$ $x$ $x$ $y$ $y$ $y$ $y$ $z$ $z$ $y \oplus z$ $y \oplus z$ $w$ $(yz) \oplus w$ $(yz) \oplus w$ $(xy \oplus yz \oplus zx) \oplus w$ 最終的に$x,y$のレジスタは変化せず、$z$のレジスタには$y,z$の加算(ただしmod 2)が入り、一番下のレジスタは、

\ket{w} \rightarrow \ket{(xy \oplus yz \oplus zx) \oplus w}となることがわかります。ここで、$(xy \oplus yz \oplus zx)$は、$x,y,z$のどれか2つ以上が1をとるときに1になり、そうでない場合0になります。ということは、$x,y,z$を全部足した結果、桁上げがある場合、$\ket{1 \oplus w}$、桁上げがない場合$\ket{0 \oplus w}$となりますので、一番下のレジスタは桁上げを表していると言えそうです。

改めて全体の回路図を見てみてください。CARRYの入力レジスタの状態は$c_{i},a_{i},b_{i},c_{i+1}$となっていますので、$a$と$b$の$i$番目の桁を足して、さらに$i-1$番目までの桁から来る桁上げの値(0または1)を足したものが、$c_{i+1}$のレジスタに入ります。どうでしょう。加算の桁上げの役割を果たしているような気がしてきますよね。

後の議論のため、上の表の記号を$x,y,z,w$ではなく、$c_{i},a_{i},b_{i},c_{i+1}$に変えて記載しておきます。

初期状態 Toffoli[1] CNOT Toffoli[2] $c_{i}$ $c_{i}$ $c_{i}$ $c_{i}$ $a_{i}$ $a_{i}$ $a_{i}$ $a_{i}$ $b_{i}$ $b_{i}$ $a_{i} \oplus b_{i}$ $a_{i} \oplus b_{i}$ $c_{i+1}$ $(a_{i}b_{i}) \oplus c_{i+1}$ $(a_{i}b_{i}) \oplus c_{i+1}$ $c_{i+1}^{\prime}$ ここで、

c_{i+1}^{\prime} = (c_{i}a_{i} \oplus a_{i}b_{i} \oplus b_{i}c_{i}) \oplus c_{i+1}とおきました。つまり、$c_{i}^{\prime}$は下の桁からやってくる桁上げの値を表しています。

ついでに、CARRYの逆演算(以下i-CARRYと呼ぶことにします)も見てみましょう。上の表を逆から読むだけです。

初期状態 Toffoli[2] CNOT Toffoli[1] $c_{i}$ $c_{i}$ $c_{i}$ $c_{i}$ $a_{i}$ $a_{i}$ $a_{i}$ $a_{i}$ $a_{i} \oplus b_{i}$ $a_{i} \oplus b_{i}$ $b_{i}$ $b_{i}$ $c_{i}^{\prime}$ $(a_{i}b_{i}) \oplus c_{i+1}$ $(a_{i}b_{i}) \oplus c_{i+1}$ $c_{i+1}$ となります。

SUMの動作

SUMは簡単です。3つの量子レジスタに対する入力を$c_{i},a_{i},b_{i}$とすると、量子状態は以下のように変化します。

初期状態 CNOT[1] CNOT[2] $c_{i}$ $c_{i}$ $c_{i}$ $a_{i}$ $a_{i}$ $a_{i}$ $b_{i}$ $a_{i} \oplus b_{i}$ $a_{i} \oplus b_{i} \oplus c_{i}$ ということで、$b_{i}$のレジスタに下の桁の桁上げも含めた加算(ただしmod 2)の結果が入ることがわかります。つまり、SUMは各桁の加算を表しています。

1量子ビットの加算

部品の動作が確認できたところで、これを組み合わせて本当に$a+b$が実行できるかを、具体的に確認してみます。まずは1量子ビットの場合です。全体の回路図を参照すると、$a,b$各々の入力が1量子ビットの場合は、以下のような回路になります。

c0=0 ---|C||------|S||--- c0=0 a0 ---|A||--*---|U||--- a0 b0 ---|R||--CX--|M||--- b0 c1=0 ---|R||------------- b1各部品の動作を表す上の表を参照しながら、この回路での状態変化を表にすると、

初期状態 CARRY CNOT SUM $c_{0}=0$ $c_{0}=0$ $c_{0}=0$ $c_{0}=0$ $a_{0}$ $a_{0}$ $a_{0}$ $a_{0}$ $b_{0}$ $a_{0} \oplus b_{0}$ $b_{0}$ $a_{0} \oplus b_{0}$ $c_{1}=0$ $c_{1}^{\prime}$ $c_{1}^{\prime}$ $c_{1}^{\prime} = b_{1}$ となります。この最終状態でレジスタ($b_{0},b_{1}$)を観測すると、ちょうど$a+b$を実行した結果に等しくなることがわかると思います(ここで$b_{0}$は下位、$b_{1}$は上位ビットを表します。この加算回路では補助量子ビット$c$の最上位を$b$の最上位ビットと同一視するようにしています)。

2量子ビットの加算

次に、2量子ビットです。回路図は、以下の通りです。

c0=0 --|C||------------------||C|--|S||-- c0=0 a0 --|A||------------------||A|--|U||-- a0 b0 --|R||------------------||R|--|M||-- b0 c1=0 --|R||--|C||------|S||--||R|-------- c1=0 a1 --------|A||--*---|U||-------------- a1 b1 --------|R||--CX--|M||-------------- b1 c2=0 --------|R||------------------------ b2先程と同様に、状態変化を表にしてみます。

初期状態 1番目のCARRY 2番目のCARRY CNOT 1番目のSUM i-CARRY 2番目のSUM $c_{0}=0$ $c_{0}$ $c_{0}$ $c_{0}$ $c_{0}$ $c_{0}$ $c_{0}=0$ $a_{0}$ $a_{0}$ $a_{0}$ $a_{0}$ $a_{0}$ $a_{0}$ $a_{0}$ $b_{0}$ $a_{0} \oplus b_{0}$ $a_{0} \oplus b_{0}$ $a_{0} \oplus b_{0}$ $a_{0} \oplus b_{0}$ $b_{0}$ $a_{0} \oplus b_{0}$ $c_{1}=0$ $c_{1}^{\prime}$ $c_{1}^{\prime}$ $c_{1}^{\prime}$ $c_{1}^{\prime}$ $c_{1}$ $c_{1}=0$ $a_{1}$ $a_{1}$ $a_{1}$ $a_{1}$ $a_{1}$ $a_{1}$ $a_{1}$ $b_{1}$ $b_{1}$ $a_{1} \oplus b_{1}$ $b_{1}$ $c_{1}^{\prime} \oplus a_{1} \oplus b_{1}$ $c_{1}^{\prime} \oplus a_{1} \oplus b_{1}$ $c_{1}^{\prime} \oplus a_{1} \oplus b_{1}$ $c_{2}=0$ $c_{2}$ $c_{2}^{\prime}$ $c_{2}^{\prime}$ $c_{2}^{\prime}$ $c_{2}^{\prime}$ $c_{2}^{\prime}=b_{2}$ となります。この最終状態でレジスタ($b_{0},b_{1},b_{2}$)を観測すると、ちょうど$a+b$を実行した結果に等しくなることがわかります。

N量子ビットの加算

3量子ビット以上の場合は、上の議論を延長してちょっと考えてみれば、確かに足し算を実行していることがわかります(2進数の足し算を筆算でやることを頭の中でイメージしていただければ、わかりやすいと思います)。

シミュレータで動作確認

重ね合わせ無し

さて、それではシミュレータで、この加算の動作を確認してみます。まず、重ね合わせがない一つの純粋状態を入力した場合です。全体のPythonコードは以下の通りです。

from qlazypy import QState def sum(self,q0,q1,q2): self.cx(q1,q2).cx(q0,q2) return self def carry(self,q0,q1,q2,q3): self.ccx(q1,q2,q3).cx(q1,q2).ccx(q0,q2,q3) return self def i_carry(self,q0,q1,q2,q3): self.ccx(q0,q2,q3).cx(q1,q2).ccx(q1,q2,q3) return self def plain_adder(self,id_a,id_b,id_c): depth = len(id_a) for i in range(depth): self.carry(id_c[i],id_a[i],id_b[i],id_c[i+1]) self.cx(id_a[depth-1],id_b[depth-1]) self.sum(id_c[depth-1],id_a[depth-1],id_b[depth-1]) for i in reversed(range(depth-1)): self.i_carry(id_c[i],id_a[i],id_b[i],id_c[i+1]) self.sum(id_c[i],id_a[i],id_b[i]) return self def encode(self,decimal,id): for i in range(len(id)): if (decimal>>i)%2 == 1: self.x(id[i]) return self def decode(self,id): iid = id[::-1] return self.m(id=iid,shots=1).lst def create_register(digits): num = 0 id_a = [i for i in range(digits)] num += len(id_a) id_b = [i+num for i in range(digits+1)] num += len(id_b) id_c = [i+num for i in range(digits+1)] id_c[digits] = id_b[digits] # share the qubit id's num += (len(id_c)-1) return (num,id_a,id_b,id_c) if __name__ == '__main__': # add metthods QState.encode = encode QState.decode = decode QState.sum = sum QState.carry = carry QState.i_carry = i_carry QState.plain_adder = plain_adder # create registers digits = 4 num,id_a,id_b,id_c = create_register(digits) # set input numbers a_list = [0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15] b = 12 for a in a_list: # initialize quantum state qs = QState(num) qs.encode(a,id_a) qs.encode(b,id_b) # execute plain adder qs.plain_adder(id_a,id_b,id_c) res = qs.decode(id_b) print("{0:}+{1:} -> {2:}".format(a,b,res)) qs.free()何をやっているか簡単に説明します。

def sum(self,q0,q1,q2): self.cx(q1,q2).cx(q0,q2) return self def carry(self,q0,q1,q2,q3): self.ccx(q1,q2,q3).cx(q1,q2).ccx(q0,q2,q3) return self def i_carry(self,q0,q1,q2,q3): self.ccx(q0,q2,q3).cx(q1,q2).ccx(q1,q2,q3) return selfで、上で説明したCARRY,i-CARRY,SUMの動作を関数として定義しています。QStateクラスのメソッドとして動的追加することを想定し、第1引数をselfにしています。

def plain_adder(self,id_a,id_b,id_c): depth = len(id_a) for i in range(depth): self.carry(id_c[i],id_a[i],id_b[i],id_c[i+1]) self.cx(id_a[depth-1],id_b[depth-1]) self.sum(id_c[depth-1],id_a[depth-1],id_b[depth-1]) for i in reversed(range(depth-1)): self.i_carry(id_c[i],id_a[i],id_b[i],id_c[i+1]) self.sum(id_c[i],id_a[i],id_b[i]) return selfで、それら部品関数を組み合わせた加算器をplain_adder関数として定義しています。これも、QStateクラスのメソッドとして動的追加するため、第1引数はselfです。第2引数以降のid_a,id_b,id_cはそれぞれa,b,cに対応した量子レジスタ番号のリストを表しています(量子レジスタの生成は別の関数create_registerで行います)。関数内部の処理は、上で説明した回路図そのものです。

def encode(self,decimal,id): for i in range(len(id)): if (decimal>>i)%2 == 1: self.x(id[i]) return selfは、入力量子ビットを設定する関数です。decimalという10進整数を、量子レジスタidに設定します(つまり、量子レジスタidを$\ket{desimal}$という状態にします)。関数内部では、decimalを2進数に直してビットが立っている桁に相当する量子レジスタのビットをXゲートで反転しています。

def decode(self,id): iid = id[::-1] return self.m(id=iid,shots=1).lstは、encodeと逆に最終状態の量子レジスタidを観測して得られた{0,1}系列から10進整数を構成してリターンします。idに相当する量子ビットだけを1回観測し、lstプロパティによってその結果(10進整数)を得ています。

def create_register(digits): num = 0 id_a = [i for i in range(digits)] num += len(id_a) id_b = [i+num for i in range(digits+1)] num += len(id_b) id_c = [i+num for i in range(digits+1)] id_c[digits] = id_b[digits] # share the qubit id's num += (len(id_c)-1) return (num,id_a,id_b,id_c)は、今回の量子レジスタの配置を決めてそのリストおよび全体で必要となる量子ビット数をリターンする関数です。digitsは入力として想定するビット数です。

一連の関数が定義できたところで、プログラムのmain部を見ていきます。まず、

QState.encode = encode QState.decode = decode QState.sum = sum QState.carry = carry QState.i_carry = i_carry QState.plain_adder = plain_adderで、上で定義した関数を、QStateクラスのメソッドとして追加しています。

digits = 4 num,id_a,id_b,id_c = create_register(digits)で、量子レジスタを決定して変数num,id_a,id_b,id_cに格納しています。量子計算(加算)の実体部分は以下です。

# set input numbers a_list = [0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15] b = 12 for a in a_list: # initialize quantum state qs = QState(num) qs.encode(a,id_a) qs.encode(b,id_b) # execute plain adder qs.plain_adder(id_a,id_b,id_c) res = qs.decode(id_b) print("{0:}+{1:} -> {2:}".format(a,b,res)) qs.free()量子ビット数はdigit=4と設定してあるので、4ビット同士の加算を実行します。ここでは、aの値を0から15まで変化させながら、固定値b=12との足し算結果を表示します。

実行結果を以下に示します。

0+12 -> 12 1+12 -> 13 2+12 -> 14 3+12 -> 15 4+12 -> 16 5+12 -> 17 6+12 -> 18 7+12 -> 19 8+12 -> 20 9+12 -> 21 10+12 -> 22 11+12 -> 23 12+12 -> 24 13+12 -> 25 14+12 -> 26 15+12 -> 27というわけで、正しく計算できることがわかりました。

重ね合わせ有り

さて、上に示したように逐次実行するのは、実は、あまり賢いやり方ではありません。量子計算では、入力値を量子重ね合わせとして用意しておけば、逐次的にぐるぐるforループを回さなくても、多数の入力値を一気に計算することができます。というわけで、やってみます。

まず、先程のencode関数の代わりに、

def superposition(self,id): for i in range(len(id)): self.h(id[i]) return selfという、入力状態を重ね合わせとして用意する関数superpositionを定義します。内部では引数として指定した量子レジスタのすべてに対してアダマールをかけています。入力が重ね合わせなので、出力も重ね合わせになります。そこから結果を引き出す関数も必要になるので、以下のように定義します。

def result(self,id_a,id_b): # measurement id_ab = id_a + id_b iid_ab = id_ab[::-1] freq = self.m(id=iid_ab).frq # set results a_list = [] r_list = [] for i in range(len(freq)): if freq[i] > 0: a_list.append(i%(2**len(id_a))) r_list.append(i>>len(id_a)) return (a_list,r_list)プログラムのmain部は以下のようになります。「重ね合わせなし」の場合との違いに注目してください。forループがないですよね。先程は15回、量子状態を初期化して量子計算をぐるぐると実行しましたが、今回は1回しか実行していません。

if __name__ == '__main__': # add methods QState.encode = encode QState.decode = decode QState.sum = sum QState.carry = carry QState.i_carry = i_carry QState.plain_adder = plain_adder # add methods (for superposition) QState.superposition = superposition QState.result = result # create registers digits = 4 num,id_a,id_b,id_c = create_register(digits) # set input numbers b = 12 # initialize quantum state qs = QState(num) qs.superposition(id_a) # set superposition of |0>,|1>,..,|15> for |a> qs.encode(b,id_b) # execute plain adder qs.plain_adder(id_a,id_b,id_c) a_list,r_list = qs.result(id_a,id_b) for i in range(len(a_list)): print("{0:}+{1:} -> {2:}".format(a_list[i],b,r_list[i])) qs.free()結果は以下の通りです。

0+12 -> 12 1+12 -> 13 2+12 -> 14 3+12 -> 15 4+12 -> 16 5+12 -> 17 6+12 -> 18 7+12 -> 19 8+12 -> 20 9+12 -> 21 10+12 -> 22 11+12 -> 23 12+12 -> 24 13+12 -> 25 14+12 -> 26 15+12 -> 27というわけで、4ビットのaの値すべてに対して一気に加算が実行できました。めでたしめでたし、と言いたいところですが、注意しておきたいことが一つあります。一気に結果が表示できるように見せかけていますが、これはシミュレータだからできることでありまして、実際の量子コンピュータでは、こんなことはできません。最終的な量子状態に対して測定をしたらば、基本一つの結果しか得られません。例えば"5+12->17"でした、という結果です。すべての加算結果を得るためには、やはり何度も何度も入力状態を用意して測定する必要があります。「なーんだ、量子コンピュータ、速くないじゃん」と思われるかもしれませんが、この例の場合は、確かにその通りかもしれません。

実際の量子計算では、求めたい結果に相当する状態の確率がなるべく高くなるように量子回路を構成し最後に測定することで、何度も計算実行しなくても、欲しい結果を効率よく得られるようにしています。量子アルゴリズムがこれまでにいろいろと提案されていますが、ざっくり言うと、要はそういうことをやっているわけです。

おわりに

今回、算術演算の中でもっとも簡単な「加算」の動作を確認しました。「Shorのアルゴリズム」で必要になる「べき剰余」に至るまで、あと何ステップかありますが、参考論文に従い、以後、順に確認していこうと思います。具体的には「剰余加算」→「制御剰余乗算」→「べき剰余」を予定しています。果たして最終ゴールまでたどり着けるかどうか...。ちょっとドキドキしてきましたが、何とか(できるところまでかもしれませんが)頑張ってみたいと思います。

以上

- 投稿日:2019-06-27T21:21:01+09:00

「魚の名前で小さな恋のうた」生成器作ってみた

「魚の名前で小さな恋のうた」生成器作ってみた

概略

Twitter 上で「魚の名前で小さな恋のうた」が話題になっていました.

これは面白い.本当に面白い.ということで作ってみました.

歌詞(日本語) を入れる入力すると,発音がそれっぽい魚の名前に変換してくれるスクリプトです.「小さな恋のうた」以外でも何でも変換できます.

結果

広い -> シロウ 宇宙の -> ウバウオ 数 -> アユ ある -> アユ ひとつ -> イトウ 青い -> サヨリ 地球の -> シラウオ 広い -> シロウ 世界で -> メカジキ 小さな -> チンアナゴ 恋の -> コイチ 思いは -> コモンハタ 届く -> ドジョウ 小さな -> チンアナゴ 島の -> シシャモ あなたの -> アカハナ もとへ -> オオセ完全版は下の方に乗せておきます.

構成

歌詞ファイル(.txt)から歌詞を分節に分解して,ローマ字化します.

似てる発音となる魚名は事前に用意した辞書ファイル(.csv)から探します.文節に分割した歌詞と魚の名前の,ローマ字のレーベンシュタイン距離が最小のものを探します.

それらをつなげて完成です.簡単.

def main(): # read lyrics if(len(sys.argv) <= 1): print("Specify a lyrics file") sys.exit(1) lyrics_file_name = sys.argv[1] lyrics_lines = [] with open(lyrics_file_name, "r") as f: lyrics_lines = f.readlines() # chunknize chunknized_lyrics = [] for lyrics_line in lyrics_lines: chunknized_lyrics += chunknize(lyrics_line) # map to romaji romaji_lyrics = [romajinize(chunk) for chunk in chunknized_lyrics] # search fish fishnized_lyrics = [fishnize(romaji_chunk) for romaji_chunk in romaji_lyrics] # print result for i in range(len(fishnized_lyrics)): print( "{} \t-> {} \t ".format(chunknized_lyrics[i], fishnized_lyrics[i]))魚の辞書の用意

まず,魚の名前の辞書を用意します.

こちらのサイトを参考にさせていただきました.

WEB 魚図鑑 和名一覧スクレイピングして魚名だけ取り出します.

こちらの際は単純に魚名だけではなく「アオダイ属未同定種」といったように

名前以外の種に関する記述が入っている場合があるのでそれは取り除きます.各魚名に関してローマ字変換したものも合わせて csv に保存しておきます.

#!/usr/bin/env python # -*- coding: utf-8 -*- import requests from bs4 import BeautifulSoup from pykakasi import kakasi kakasi = kakasi() kakasi.setMode('H', 'a') kakasi.setMode('K', 'a') kakasi.setMode('J', 'a') conv = kakasi.getConverter() URL = "https://zukan.com/fish/level5" res = requests.get(URL) soup = BeautifulSoup(res.text, 'html.parser') soup = soup.select( "#alphabetal_order a") with open('fish_name_list.csv', 'w') as f: f.write("name,romaji\n") # set header for s in soup: t = s.text t = t if t.find("属") == -1 else t[:t.find("属")] t = t if t.find("科") == -1 else t[:t.find("科")] t = t if t.find("群") == -1 else t[:t.find("群")] t = t if t.find("L") == -1 else t[:t.find("L")] t = t if t.find("太") == -1 else t[:t.find("太")] t = t if t.find("日") == -1 else t[:t.find("日")] t = t if t.find("」") == -1 else t[:t.find("」")] t = t if t.find("「") == -1 else t[t.find("「")+1:] if t != "": f.write(t + ","+conv.do(t)+"\n")歌詞の文節分割

CaboCha というものを用いました.

CaboCha/南瓜CaboCha はまともなドキュメントがなく大変でした.

感謝して読みました.

CaboCha/南瓜 Python Document (CaboCha.py)どうやら分節ごと区切れるけど,そのまま出力する機能はない?ようなので,

一つづつチャンク(文節)を読み込んでいって

token_size(含まれている単語の数)分だけ単語を読んで足します.chunk の先頭の場所を表すのに chunk.token_pos だったり,単語の文字自体を

出すのが token.surface だったりとよくわかりませんでした.なんとかやっつけました.for i in range(t.chunk_size()): chunk = "" token_pos = t.chunk(i).token_pos for j in range(t.chunk(i).token_size): chunk += t.token(token_pos+j).surface chunknized_string.append(chunk)全体的にはこんなふうになりました.

def chunknize(string): chunknized_string = [] c = CaboCha.Parser() t = c.parse(string) for i in range(t.chunk_size()): chunk = "" token_pos = t.chunk(i).token_pos for j in range(t.chunk(i).token_size): chunk += t.token(token_pos+j).surface chunknized_string.append(chunk) return chunknized_stringCaboCha はハマりポイントが 2 つあって

環境が /usr/local/lib にパスが通っていなかったため Not Found のエラーが出続けていました.

また,CaboCha の前に MeCab をインストールする際に辞書を UTF-8 でやっておかないと辞書関連でエラーが出ます.(詳しく覚えてなくてすみません.)適用部分はこのようになっています.

# read lyrics if(len(sys.argv) <= 1): print("Specify a lyrics file") sys.exit(1) lyrics_file_name = sys.argv[1] lyrics_lines = [] with open(lyrics_file_name, "r") as f: lyrics_lines = f.readlines() # chunknize chunknized_lyrics = [] for lyrics_line in lyrics_lines: chunknized_lyrics += chunknize(lyrics_line)lyrics_file を直接文節に区切るのではなく一度 readline()してから分節化したのには理由があります.

歌詞は文法に則った正確な日本語ではないため,自立語と付属語の区別に失敗し,上手にパースされないことがあります.

「小さな恋のうた」を例に上げると,ただ あなたにだけ届いて欲しい 響け恋の歌 ほら ほら ほら 響け恋の歌この部分の「ほら」が正確に解釈されなかったりしました.

一行ごと分節化することで「ほら」のみ分節化対象にできるのでこの問題が解決できます.文節のローマ字化

pykakasi というものを用います.

pip を使うとエラーが出るらしいので使わず自分でビルドしました.参考 漢字をローマ字に変換できる Python ライブラリ "pykakasi" を使ってみた。

kakasi = pykakasi.kakasi() kakasi.setMode('H', 'a') kakasi.setMode('K', 'a') kakasi.setMode('J', 'a') conv = kakasi.getConverter()こんなものを定義しておいて次のように用意すれば良いです.

def romajinize(string): return conv.do(string)適用部分はこのようになっています.

# map to romaji romaji_lyrics = [romajinize(chunk) for chunk in chunknized_lyrics]検索

一番中核なところ.ローマ字の文節とローマ字の魚名のレーベンシュタイン距離をもとに

文節を魚名に変換します.レーベンシュタイン距離

レーベンシュタイン距離は名前だけすごそうですが,定義自体は難しくありません.

何文字変えればその文字になりますか?というものです.

小さいほどその文字は似ているということになります.詳しくはこちら

編集距離(レーベンシュタイン距離)を理解し、実装するLevenshtein というライブラリがあるので import して,

Levenshtein.distance(str1, str2)で,求めることができます.

今回のの実装では n_levenshtein_distance_with_threshold 関数内部で使用しています.

n(正規化した)_levenshtein_distance(レーベンシュタイン距離)_with_threshold(母音数の制限あり)

という実装にしました.

これは本当にいきあたりばったりで実装した部分で余分に複雑なので後ほど解説します.ともかく,ここで歌詞の文節と魚名の距離を算出しているというところが大切です.

変換部分

文節に対し,各魚のローマ字名との距離をリストに格納します.

その中で最小のものを取り出すようにしています.index()の挙動上,最短距離であるものが複数ある場合は,辞書内で一番若いものになります.

いちいち全部の魚名に対して距離を計算するのは遅くなってしまうので褒められた方法ではありません.おそらくこれが原因でとても遅いです.

ただ,冗長性とかもない気がするので難しいですが考え中です.実装はこのようになっています.

def fishnize(string): fish_table["distance"] = [] for romaji_fish_name in fish_table["romaji"]: fish_table["distance"].append( n_levenshtein_distance_with_threshold(romaji_fish_name, string)) index = fish_table["distance"].index(min(fish_table["distance"])) return fish_table["name"][index]適用部分はこのようになっています.

# search fish fishnized_lyrics = [fishnize(romaji_chunk) for romaji_chunk in romaji_lyrics]結果

あとは出力するだけです.

# print result for i in range(len(fishnized_lyrics)): print( "{} \t-> {} \t ".format(chunknized_lyrics[i], fishnized_lyrics[i]))

小さな恋の歌全体を変換するとこのようになります.

広い -> シロウ

宇宙の -> ウバウオ

数 -> アユ

ある -> アユ

ひとつ -> イトウ

青い -> サヨリ

地球の -> シラウオ

広い -> シロウ

世界で -> メカジキ

小さな -> チンアナゴ

恋の -> コイチ

思いは -> コモンハタ

届く -> ドジョウ

小さな -> チンアナゴ

島の -> シシャモ

あなたの -> アカハナ

もとへ -> オオセ

あなたと -> ハナタツ

出会い -> ヘダイ

時は -> トミヨ

流れる -> マガレイ

思いを -> ウメイロ

込めた -> コボラ

手紙も -> タマギンポ

増える -> ブリル

いつしか -> イシダイ

二人 -> ニタリ

互いに -> タラキヒ

響く -> チチブ

時に -> トウジン

激しく -> アメギス

時に -> トウジン

切なく -> セトダイ

響くは -> ヒシコバン

遠く -> ポラック

遥かかなたへ -> ホカケアナハゼ

やさしい -> ナガサギ

歌は -> ワタカ

世界を -> メカジキ

変える -> カツオ

ほら -> ヒラ

あなたにとって -> アカタナゴ

大事な -> ハシキンメ

人ほど -> カナド

すぐ -> スギ

そばに -> サバヒー

いるの -> キレンコ

ただ -> アラ

あなたにだけ -> アカタナゴ

届いて欲しい -> ソコイトヨリ

響け -> ヒラメ

恋の -> コイチ

歌 -> スマ

ほら -> ヒラ

ほら -> ヒラ

ほら -> ヒラ

響け -> ヒラメ

恋の -> コイチ

歌 -> スマ

あなたは -> アカタチ

気付く -> スズキ

二人は -> カワビシャ

歩く -> カラス

暗い -> キダイ

道でも -> ギチベラ

日々 -> ギギ

照らす -> カラス

月 -> ダツ

握りしめた -> キビレミシマ

手離す -> カワマス

こと -> コイ

なく -> アユ

思いは -> コモンハタ

強く -> ウツボ

永遠誓う -> キチヌ

永遠の -> キリンミノ

淵きっと -> ウシエイ

僕は -> コクレン

言う -> ギス

思い変わらず -> アメリカナマズ

同じ -> マアジ

言葉を -> コトヒキ

それでも -> オキエソ

足りず -> カラス

涙に -> ナミハタ

変わり -> カンダリ

喜びに -> モロコシハギ

なり -> アラ

言葉に -> コトヒキ

できず -> メギス

ただ -> アラ

抱きしめる -> アカヒメジ

ただ抱きしめる -> タカサゴヒメジ

ほら -> ヒラ

あなたにとって -> アカタナゴ

大事な -> ハシキンメ

人ほど -> カナド

すぐ -> スギ

そばに -> サバヒー

いるの -> キレンコ

ただ -> アラ

あなたにだけ -> アカタナゴ

届いて欲しい -> ソコイトヨリ

響け -> ヒラメ

恋の -> コイチ

歌 -> スマ

ほら -> ヒラ

ほら -> ヒラ

ほら -> ヒラ

響け -> ヒラメ

恋の -> コイチ

歌 -> スマ

夢ならば -> ユメカサゴ

覚めないで -> サメガレイ

夢ならば -> ユメカサゴ

覚めないで -> サメガレイ

あなたと -> ハナタツ

過ごした -> アゴハタ

時 -> コイ

永遠の -> キリンミノ

星と -> シシャモ

なる -> アユ

ほら -> ヒラ

あなたにとって -> アカタナゴ

大事な -> ハシキンメ

人ほど -> カナド

すぐ -> スギ

そばに -> サバヒー

いるの -> キレンコ

ただ -> アラ

あなたにだけ -> アカタナゴ

届いて欲しい -> ソコイトヨリ

響け -> ヒラメ

恋の -> コイチ

歌 -> スマ

ほら -> ヒラ

あなたにとって -> アカタナゴ

大事な -> ハシキンメ

人ほど -> カナド

すぐ -> スギ

そばに -> サバヒー

いるの -> キレンコ

ただ -> アラ

あなたにだけ -> アカタナゴ

届いて欲しい -> ソコイトヨリ

響け -> ヒラメ

恋の -> コイチ

歌 -> スマ

ほら -> ヒラ

ほら -> ヒラ

ほら -> ヒラ

響け -> ヒラメ

恋の -> コイチ

歌 -> スマ

いかがでしょうか?

コード全体は以下のようになりました.

もしかしたら GitHub 上のものは書き換えるかも,というか書き換えたい.

import sys import pandas as pd import CaboCha import pykakasi import Levenshtein import re def romajinize(string): return conv.do(string) def normalized_levenshtein_distance(str1, str2): max_len = max([len(str1), len(str2)]) return Levenshtein.distance(str1, str2)/max_len def count_vowels(string): n_vowel = 0 for vowel in ["a", "i", "u", "e", "o"]: n_vowel += len(re.findall(vowel, string)) return n_vowel def n_levenshtein_distance_with_threshold(str1, str2, threshold=0): n_str1_vowel = count_vowels(str1) n_str2_vowel = count_vowels(str2) return normalized_levenshtein_distance(str1, str2) if n_str2_vowel >= 5 or abs(n_str1_vowel - n_str2_vowel) <= threshold else 100 def fishnize(string): fish_table["distance"] = [] for romaji_fish_name in fish_table["romaji"]: fish_table["distance"].append( n_levenshtein_distance_with_threshold(romaji_fish_name, string)) index = fish_table["distance"].index(min(fish_table["distance"])) return fish_table["name"][index] def chunknize(string): chunknized_string = [] c = CaboCha.Parser() t = c.parse(string) for i in range(t.chunk_size()): chunk = "" token_pos = t.chunk(i).token_pos for j in range(t.chunk(i).token_size): chunk += t.token(token_pos+j).surface chunknized_string.append(chunk) return chunknized_string def main(): # read lyrics if(len(sys.argv) <= 1): print("Specify a lyrics file") sys.exit(1) lyrics_file_name = sys.argv[1] lyrics_lines = [] with open(lyrics_file_name, "r") as f: lyrics_lines = f.readlines() # chunknize chunknized_lyrics = [] for lyrics_line in lyrics_lines: chunknized_lyrics += chunknize(lyrics_line) # map to romaji romaji_lyrics = [romajinize(chunk) for chunk in chunknized_lyrics] # search fish fishnized_lyrics = [fishnize(romaji_chunk) for romaji_chunk in romaji_lyrics] # print result for i in range(len(fishnized_lyrics)): print( "{} \t-> {} \t ".format(chunknized_lyrics[i], fishnized_lyrics[i])) conv = None fish_table = None if __name__ == "__main__": kakasi = pykakasi.kakasi() kakasi.setMode('H', 'a') kakasi.setMode('K', 'a') kakasi.setMode('J', 'a') conv = kakasi.getConverter() fish_table = {"name": [], "romaji": []} with open("fish_name_list.csv", "r") as f: for line in f.readlines()[1:]: # skip the headr line values = line.split(",") fish_table["name"].append(values[0]) fish_table["romaji"].append(values[1][:-1]) # remove \n main()hoge.py とかで保存して

$python hoge.py lyrics.txtってすればどんな歌詞でも変換できます.ぜひ試してみてください.

改善点

改善点もやっぱりあります.

「恋の歌」はひとかたまりとして扱いたいですが,文節として区切ってしまうと別れてしまうので,まとめて扱うものを指定する機能とかあったらいいですね,

歌詞は記号とかを現段階では想定してないので対応したい.

レーベンシュタイン距離よりもよい距離を見つける.

上 2 つはできそうですが 3 つ目は難しいです.

レーベンシュタイン距離よりもよい距離を見つける.

ほら -> ヒラ

友人「ボラじゃないじゃん」

僕「...はい」確かに,「ヒラ」よりも「ボラ」のほうがチカイ気がします.

レーベンシュタイン距離というのはそもそも何文字編集すればいいか,という数

なので音声ではなくテキストベースの距離だと言えます.

音声的にチカイ単語を検索したい今回では最適とは言い難いです.英語では Soundex や Metaphone といったスペルから発音に変換する

アルゴリズムが存在しますが,

ざっと探した限りでは日本語ではそれに当たるものが見当たりませんでした.

- IPA

基本的にはこちらの論文を参考にしました.ほぼ読んでいないですが,国際発音記号の IPA の

レーベンシュタイン距離を計測して空耳を作成していました.しかし,日本語を IPA に変換するツールでポピュラーなものはなさそうなのでこの手法は採用しませんでした.

- カタカナ

そもそもカタカナは表音文字であることを思い出し,レーベンシュタイン距離出やりました.

とてもじゃないですが載せられないくらい制度が悪かったです.

文節は文字数が少ないです.4 文字の場合一文字変えるだけで 25%違う単語になります.

候補が大量に出て,トオイ文字に変換されてしまいました.

(結果残しておけばよかった)

- ローマ字

文字数が少ないことが問題になったので文字数を増やしつつ,発音を表せるローマ字を選択.

割と改善しました.(結果残しておけばよかった)

しかしながら,似てはいるものの次は日本語にした時の文字数が合わなかったりしました.

歌なので文字数が増えてしまうと歌いにくいです.

- 標準化レーベンシュタイン距離

4 文字中の 1 文字変更は影響が大きいですが,10 文字中の 1 文字変更は影響が小さいです.

標準化レーベンシュタイン距離はどのくらいの割合変更すると一方の文字になれるかを表していると言えます.標準化レーベンシュタイン距離は値の範囲が 0~1 になるので候補の数が減らせるのではないかと期待して導入しました.

https://qiita.com/Ishio/items/d52b9221c92bd4ebb344

こんなふうに実装できます.

def normalized_levenshtein_distance(str1, str2): max_len = max([len(str1), len(str2)]) return Levenshtein.distance(str1, str2)/max_len候補 1 と候補 2 の文字数とレーベンシュタイン距離距離が同じ場合,複数の候補になってしまいます.

- 母音の数を考慮に入れてローマ字

現在のスタイルです.歌いづらいのは音節の数が揃っていないからなので,

両者の母音の数が等しいまたは近いもののみ候補に入れて距離を計算します.文字数が多い場合はちょっとくらいずれていても問題ないので母音が 5 個以上ある場合は

母音数を考慮して距離計算していません.逆に言えば母音数 4 個以下(カタカナで 4 文字以下くらい)の歌詞は必ず母音数が一致します.

割と良かったです.

実装はこのようになりました.

def count_vowels(string): n_vowel = 0 for vowel in ["a", "i", "u", "e", "o"]: n_vowel += len(re.findall(vowel, string)) return n_vowel def n_levenshtein_distance_with_threshold(str1, str2, threshold=0): n_str1_vowel = count_vowels(str1) n_str2_vowel = count_vowels(str2) return normalized_levenshtein_distance(str1, str2) if n_str2_vowel >= 5 or abs(n_str1_vowel - n_str2_vowel) <= threshold else 100いい距離の条件

- 音声ベースの計測方法であること.

レーベンシュタイン距離はテキストベースなので変更したいですが,そんなものが存在するのか知らないので

教えください.

- 複数候補が出ることがない

標準化レーベンシュタイン距離は実数なのでバラけることを期待しましたが,

全体的に文字数が似ているので距離が一致してしまうものもありました.

「ヒラ」と「ボラ」などもっとバラける実数値だと良いんだと思います.

- かぶって変換しない

異なる単語に対しては異なる魚名に変換して欲しいです.

歌詞のリズムが崩れてしまいます.数 -> アユ

ある -> アユ見つかったらいいな.

感想

なんか改善点長いですね.

GitHub にあげておいたので改良するかも.

SingFishでも,できました.意外と楽しくできてよかったです.

届いて欲しい -> ソコイトヨリ

なんて結構お気に入りです.ちょうどよい無理矢理感です.

- 投稿日:2019-06-27T18:54:26+09:00

【Airflow on Kubernetes】DockerイメージのbuildとPodのdeployの仕組みについて

概要

Airflowでは、Kubernetes用のDockerイメージの作成スクリプトと、Podのdeploy用のスクリプトが用意されている。

GitHUB: https://github.com/apache/airflowこれらのスクリプトが実際にどのような処理を行っているのかを調べた。

関連記事

おおまかな処理の流れ

処理の流れを大きく分けると、以下の2つに分けられる。

- Dockerイメージをbuildする

- Podをdeployをする

以降で、それぞれの詳細な処理について追っていく。

Dockerイメージをbuildする

Dockerイメージをbuildするための、build.shの処理内容を追う。

実際に実行させる場合は、以下の様にする。

$ sudo ./scripts/ci/kubernetes/docker/build.shbuild.shを実行してairflowのDockerイメージを作成する

build.sh#L46でcompile.shが実行される。

scripts/ci/kubernetes/docker/build.sh#L46docker run -it --rm -v ${AIRFLOW_ROOT}:/airflow \ -w /airflow ${PYTHON_DOCKER_IMAGE} ./scripts/ci/kubernetes/docker/compile.shbuild.shの中でcompile.shが実行される

compile.sh#L32でsetup.pyが実行されると、ホストOSに

~/airflow/dist/というディレクトリが生成され、その下にapache-airflow-2.0.0.dev0.tar.gzというファイルが生成される。

これが、airflowのソースコードとなるものである。scripts/ci/kubernetes/docker/compile.sh#L32# apache-airflow-2.0.0.dev0.tar.gzが生成される python setup.py compile_assets sdist -qcompile.shでairflowのtarファイルが作成されると、build.sh#L51で、先程生成された

apache-airflow-2.0.0.dev0.tar.gzが、scripts/ci/kubernetes/docker/airflow.tar.gzにリネームしてコピーされる。scripts/ci/kubernetes/docker/build.sh#L51cp $AIRFLOW_ROOT/dist/*.tar.gz ${DIRNAME}/airflow.tar.gzbuild.shの中でairflowのDockerイメージをbuildする

build.sh#L52で、

docker buildが実行される。build.sh#L52cd $DIRNAME && docker build --pull $DIRNAME --tag=${IMAGE}:${TAG}このときに、このDockerfileが読み込まれる。

Dockerfileの処理

Dockerfile#L43で、先程生成されたホストOSの

scripts/ci/kubernetes/docker/airflow.tar.gzがコンテナ内にCOPYされる。Dockerfile#L43# コンテナ内にCOPY COPY airflow.tar.gz /tmp/airflow.tar.gzDockerfileの中でairflow-test-env-init.shが実行される

次にDockerfile#L46で、airflow-test-env-init.shが実行される。

Dockerfile#L46COPY airflow-test-env-init.sh /tmp/airflow-test-env-init.shすると、airflow-test-env-init.sh#L23で、コンテナ内の

/usr/local/lib/python3.6/site-packages/airflow/example_dags/を、PersistentVolumeのmount先である/root/airflow/dags/にコピーする。airflow-test-env-init.sh#L23# example_dags/とcontrib/example_dags/をPersistentVolumeにコピー cd /usr/local/lib/python3.6/site-packages/airflow && \ cp -R example_dags/* /root/airflow/dags/ && \ cp -R contrib/example_dags/example_kubernetes_*.py /root/airflow/dags/ && \ cp -a contrib/example_dags/libs /root/airflow/dags/ && \build.shの処理はこれで完了。

Deploy

Podをdeployするための、deploy.shの処理内容を追う。

実際に実行させる場合は、以下の様にする。

-dオプションで、dags_folderの追加方法をpersistent_modeかgit_modeのどちらかから選ぶ。usage: ./scripts/ci/kubernetes/kube/deploy.sh options OPTIONS: -d Use PersistentVolume or GitSync for dags_folder. Available options are "persistent_mode" or "git_mode"実行

$ sudo ./scripts/ci/kubernetes/kube/deploy.sh -d {persistent_mode,git_mode}deploy.shを実行

deploy.shを実行して、Podをdeployする。

実行されると、scripts/ci/kubernetes/kube/templates以下のmanifestのテンプレートファイルの必要箇所が置換されて、

scripts/ci/kubernetes/kube/buildの下に生成される。

生成されたmanifestファイルを使ってkubectl applyが実行される。$ ls -1 scripts/ci/kubernetes/kube/templates/ airflow.template.yaml configmaps.template.yaml init_git_sync.template.yamlInitContainer

ci/kubernetes/kube/templates/airflow.template.yamlを元にして生成された、scripts/ci/kubernetes/kube/build/airflow.yamlをapplyすると、airflow.yaml#L69で定義されているInitContainerが実行され、deployの際にInitContainerでもairflow-test-env-init.shが実行される。

ここで、コンテナ内の

/usr/local/lib/python3.6/site-packages/airflow/example_dags/が、PodのPersistentVolumeのmount先である/root/airflow/dags/にコピーされる。airflow.template.yaml#一部抜粋spec: initContainers: - name: "init" image: {{AIRFLOW_IMAGE}}:{{AIRFLOW_TAG}} imagePullPolicy: IfNotPresent volumeMounts: - name: airflow-configmap mountPath: /root/airflow/airflow.cfg subPath: airflow.cfg - name: {{INIT_DAGS_VOLUME_NAME}} mountPath: /root/airflow/dags - name: test-volume mountPath: /root/test_volume env: - name: SQL_ALCHEMY_CONN valueFrom: secretKeyRef: name: airflow-secrets key: sql_alchemy_conn command: - "bash" args: - "-cx" - "./tmp/airflow-test-env-init.sh"deploy.shの処理はこれで完了。

dagsの確認

Pod内を確認。/root/airflow/dags/だけでなく、/usr/local/lib/python3.6/site-packages/airflow/example_dags/にもファイルがあることがわかる。

Pod内に入って確認してみる。

$ sudo kubectl exec -it airflow-xxxxxxxxxx-xxxxx /bin/bashPod内の/usr/local/lib/python3.6/site-packages/airflow/example_dags/を確認。

root@airflow-xxxxxxxxxx-xxxxx:/# ls -1 /usr/local/lib/python3.6/site-packages/airflow/example_dags/ __init__.py __pycache__ docker_copy_data.py example_bash_operator.py example_branch_operator.py example_branch_python_dop_operator_3.py example_docker_operator.py example_http_operator.py example_latest_only.py example_latest_only_with_trigger.py example_passing_params_via_test_command.py example_pig_operator.py example_python_operator.py example_short_circuit_operator.py example_skip_dag.py example_subdag_operator.py example_trigger_controller_dag.py example_trigger_target_dag.py example_xcom.py subdags test_utils.py tutorial.pyPod内の/root/airflow/dags/以下を確認。

root@airflow-xxxxxxxxxx-xxxxx:/# ls -1 /root/airflow/dags/ __init__.py __pycache__ docker_copy_data.py example_bash_operator.py example_branch_operator.py example_branch_python_dop_operator_3.py example_docker_operator.py example_http_operator.py example_kubernetes_executor.py example_kubernetes_executor_config.py example_kubernetes_operator.py example_latest_only.py example_latest_only_with_trigger.py example_passing_params_via_test_command.py example_pig_operator.py example_python_operator.py example_short_circuit_operator.py example_skip_dag.py example_subdag_operator.py example_trigger_controller_dag.py example_trigger_target_dag.py example_xcom.py libs subdags test_utils.py tutorial.pyどちらにもdagファイルがあるが、/root/airflow/dags/のほうがファイルが多い。

これはairflow-test-env-init.shを見ると分かるが、example_dags/だけでなく、contrib/example_dags/以下のファイルもコピーされているためである。airflow-test-env-init.sh#L23cp -R example_dags/* /root/airflow/dags/ && \ cp -R contrib/example_dags/example_kubernetes_*.py /root/airflow/dags/ && \ cp -a contrib/example_dags/libs /root/airflow/dags/ && \Hackする

同期されるdagファイルを変更する場合

airflow-test-env-init.sh#L23

の以下の箇所を変更することで、同期されるdagファイルを変更することができる。airflow-test-env-init.sh#L23cp -R example_dags/* /root/airflow/dags/ && \ cp -R contrib/example_dags/example_kubernetes_*.py /root/airflow/dags/ && \ cp -a contrib/example_dags/libs /root/airflow/dags/ && \PersistentVolumeのmount先を変更する方法

以下2つのvolumeの定義を変更する。

- airflowのファイル群のmount先

- scripts/ci/kubernetes/kube/volumes.yaml

- postgresのデータのmount先

- scripts/ci/kubernetes/kube/postgres.yaml

参考

- 投稿日:2019-06-27T17:46:33+09:00

[Heroku]Django WEB App デプロイ(完)2019/6(下書き)

Django製アプリを「Heroku」へのデプロイ

はじめに

この記事を見てくださっている方はいくつものサイトを見ては、エラーを繰り返している方も多いと思います。

僕はデプロイに丸一日を要しました。他サイトを見ながら試行錯誤してやっとデプロイできましたが、なんせ、拡張子なしのファイル(後で出てきます)の作り方すら知らなかった僕にとっては、もう少し詳しく教えて欲しい!というところも多かったです。

もちろん、記事を書いてくださる方には感謝していますし、この記事よりも専門的な知識は多く得られます。

ですので、この記事では細かな説明もしつこいくらいに入れていきながら解説したいと思います。

読んでくださる方が多くても数時間でデプロイできるようにしたいと思います。(一回もエラーが出ないなら、30分もかかりません。)前提条件(対象者)

- データベース(MySQL, phpMyAdmin)を用いたアプリ

- ローカルホストではきちんと動作するアプリが完成している

- Herokuのアカウントを持っている(無料)

- GitHub, git のコマンドを使える(僕のように調べながらでも使えればいいと思います)

開発環境

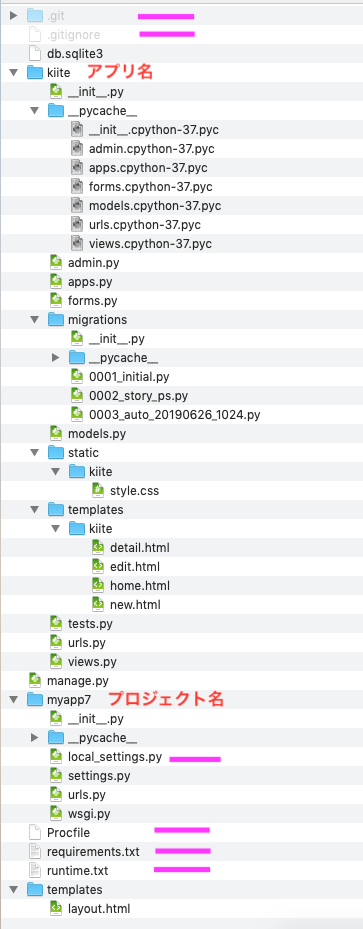

Mac OS python 3.7.3 dj-database-url 0.5.0 #後でインストールします Django 2.1 django-bootstrap4 0.0.8 gunicorn 19.9.0 #後でインストールします pip 19.1.1 psycopg2-binary 2.8.3 #後でインストールします PyMySQL 0.9.3 pytz 2019.1 #後でインストールします setuptools 41.0.1 sqlparse 0.3.0 whitenoise 3.3.1 #後でインストールします #「後でインストール」以外のものは、必要かはわかりません。 #ローカルで動いているのなら、この[pip list]はそんなに気にすることもないと思います。最終的なファイル構成

どこのファイルかわからない(説明不足)時は、この画像で判断してください。

紫色の線のファイルはこの後追加します。他のファイルはみなさんあると思います。(場合によって、staticファイルとかはないかも)

必要なものをインストールする

下記のように、必要なものをインストールしてください。

※注意(下の文を必ず読んでください)

「whitenoise」はバージョン3を指定してください。指定しないと4がインストールされ、この記事の方法だとうまくいきません。

また、「psycopg2」のインストールができない場合は「pip install psycopg2-binary」をインストールしてください。

pip install gunicorn django-herokuで下記のものを一括インストールできるらしいが、僕はできませんでした。

試してみるのもありかもしれないです。terminal(dj)$ pip install dj-database-url (dj)$ pip install gunicorn (dj)$ pip install whitenoise==3.3.1 ?バージョンを指定しないと whitenoise4.x.x がインストールされる (dj)$ pip install psycopg2 ?エラーが出る可能性あり (dj)$ pip install pytzファイルを追加する

Herokuへデプロイするのに必要なファイルを作成していきます。

(.gitignore, Procfile, requirements.txt, runtime.txtを追加します。)「.gitignore」を追加する

terminal#いつもの開発環境(venv)で実行してください。 (dj)$ cd myapp7 ?プロジェクトに移動(外側のディレクトリであることに注意)(myapp7のところは自分のに変える) (dj)myapp7 $ touch .gitignore ?これを実行すると「.gitignore」が作られる Mac の場合は、Finderで「Shift + cmd + .」で見えるようになる「.gitignore」を編集する

「.gitignore」を開いて、以下のように編集

(dj の部分は人によって異なる).gitignoredj ?これは自分の開発環境の名前(terminalの$マークの後ろの文字) __pycache__ staticfiles db.sqlite3 *.py[co]「Procfile」を追加する

terminal#先ほどの続きで問題ないです。ディレクトリは外側のmyapp7 (dj)myapp7 $ touch Procfile ?これを実行すると「Procfile」が作られる Mac の場合は、Finderで「Shift + cmd + .」で見えるようになる「Procfile」を編集する

Procfileはこの1行だけです。

スペースなどを省略するとエラーの原因になるため、コピペをお勧めします。

そのあとに、myapp7の部分を自分のプロジェクト名に変更してください。Procfileweb: gunicorn myapp7.wsgi --log-file -「requirements.txt」を追加する

下のコマンドを実行するだけでOK

terminal(dj)myapp7 $ pip freeze > requirements.txt念の為、下のように記載されたファイルができているか確認してください。

requirements.txtdj-database-url==0.5.0 Django==2.1 django-bootstrap4==0.0.8 gunicorn==19.9.0 psycopg2-binary==2.8.3 PyMySQL==0.9.3 pytz==2019.1 sqlparse==0.3.0 whitenoise==3.3.1 psycopg2==2.7.6.1 ?上で「psycopg2」がインストールできなかった人は追加「runtime.txt」を追加する

これは、CotEditorなり、普通のテキストエディタなりを開いて以下の1行を書きこんで保存してください。(このファイルは、Procfile同様に1行だけ)

保存場所は上の最初の画像を参照。

pythonのバージョンは自分が使用しているものに置き換えてください。

ただし、python2は想定していません。ご了承ください。python-3.7.3「local_settings.py」を作成する

settings.pyのデータベース接続部分をコピーして、新たに作成する「local_settings.py」に貼り付けします。(このファイルの保存場所は上の画像を確認してください。)

①settings.pyからDATABASEの部分をコピーする(DATABASEの部分は人によって異なると思います。)

②local_settings.pyという名前で新たに作成したファイルに、貼り付け(下のような感じになります。少しも省略していないため、local_settings.pyはこれが全てです。)

「?」の部分以外は人によって異なると思います。(Django2, MySQL, phpMyAdminの組み合わせの人は、

"NAME": "kiitedb",以外は下と全く同じになっても不思議ではありません。)local_settings.pyimport os ? BASE_DIR = os.path.dirname(os.path.dirname(os.path.abspath(__file__))) ? import pymysql pymysql.install_as_MySQLdb() DATABASES = { 'default': { #'ENGINE': 'django.db.backends.sqlite3', #'NAME': os.path.join(BASE_DIR, 'db.sqlite3'), "ENGINE": "django.db.backends.mysql", "NAME": "kiitedb", "USER": "root", "PASSWORD": "root", "HOST": "127.0.0.1", "PORT": "3306", } } DEBUG = True ?

- 投稿日:2019-06-27T17:46:33+09:00

[Heroku]Django WEB App デプロイ(完)2019/6月版

Django製アプリを「Heroku」へのデプロイ

コード:https://github.com/MachinoTensei/kiite-kikasete

はじめに

この記事を見てくださっている方はいくつものサイトを見ては、エラーを繰り返している方も多いと思います。

僕はデプロイに丸一日を要しました。他サイトを見ながら試行錯誤してやっとデプロイできましたが、なんせ、拡張子なしのファイル(後で出てきます)の作り方すら知らなかった僕にとっては、もう少し詳しく教えて欲しい!というところも多かったです。

もちろん、記事を書いてくださる方には感謝していますし、この記事よりも専門的な知識は多く得られます。

ですので、この記事では細かな説明もしつこいくらいに入れていきながら解説したいと思います。

そのため、長めの記事ですが、やっていることはそんなに多くありません。

読んでくださる方が、多くても数時間でデプロイできるようにしたいと思います。(一回もエラーが出ないなら、30分もかかりません。)前提条件(対象者)

- データベース(MySQL, phpMyAdmin)を用いたアプリを作成済み

- ローカルホストではきちんと動作するアプリが完成している

- Herokuのアカウントを持っている(無料)

- GitHub, git のコマンドを使える(僕のように調べながらでも使えればいいと思います)

開発環境

Mac OS python 3.7.3 dj-database-url 0.5.0 #後でインストールします Django 2.1 django-bootstrap4 0.0.8 gunicorn 19.9.0 #後でインストールします pip 19.1.1 psycopg2-binary 2.8.3 #後でインストールします PyMySQL 0.9.3 pytz 2019.1 #後でインストールします setuptools 41.0.1 sqlparse 0.3.0 whitenoise 3.3.1 #後でインストールします #「後でインストール」以外のものは、必要かはわかりません。 #ローカルで動いているのなら、この[pip list]はそんなに気にすることもないと思います。最終的なファイル構成

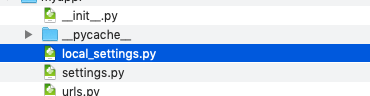

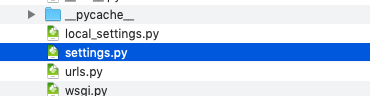

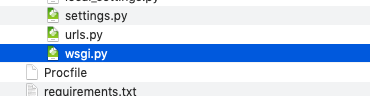

どこのファイルかわからない(説明不足)時は、この画像で判断してください。

紫色の線のファイルはこの後追加します。他のファイルはみなさんあると思います。(場合によって、staticファイルとかはないかも)

(1)必要なものをインストールする

下記のように、必要なものをインストールしてください。

※注意(下の文を必ず読んでください)

「whitenoise」はバージョン3を指定してください。指定しないと4がインストールされ、この記事の方法だとうまくいきません。

また、「psycopg2」のインストールができない場合は「pip install psycopg2-binary」をインストールしてください。

pip install gunicorn django-herokuで下記のものを一括インストールできるらしいが、僕はできませんでした。

試してみるのもありかもしれないです。terminal(dj)$ pip install dj-database-url (dj)$ pip install gunicorn (dj)$ pip install whitenoise==3.3.1 ?バージョンを指定しないと whitenoise4.x.x がインストールされる (dj)$ pip install psycopg2 ?エラーが出る可能性あり (dj)$ pip install pytz(2)ファイルを追加する

Herokuへデプロイするのに必要なファイルを作成していきます。

(.gitignore, Procfile, requirements.txt, runtime.txtを追加します。)(2-1)「.gitignore」を新規作成

terminal#いつもの開発環境(venv)で実行してください。 (dj)$ cd myapp7 ?プロジェクトに移動(外側のディレクトリであることに注意)(myapp7のところは自分のに変える) (dj)myapp7 $ touch .gitignore ?これを実行すると「.gitignore」が作られる Mac の場合は、Finderで「Shift + cmd + .」で見えるようになる(2-2)「.gitignore」を編集する

「.gitignore」を開いて、以下のように編集

(dj の部分は人によって異なる).gitignoredj ?これは自分の開発環境の名前(terminalの$マークの後ろの文字) __pycache__ staticfiles db.sqlite3 *.py[co](2-3)「Procfile」を新規作成

terminal#先ほどの続きで問題ないです。ディレクトリは外側のmyapp7 (dj)myapp7 $ touch Procfile ?これを実行すると「Procfile」が作られる Mac の場合は、Finderで「Shift + cmd + .」で見えるようになる(2-4)「Procfile」を編集する

Procfileはこの1行だけです。

スペースなどを省略するとエラーの原因になるため、コピペをお勧めします。

そのあとに、myapp7の部分を自分のプロジェクト名に変更してください。Procfileweb: gunicorn myapp7.wsgi --log-file -(2-5)「requirements.txt」を新規作成

下のコマンドを実行するだけでOK

terminal(dj)myapp7 $ pip freeze > requirements.txt念の為、下のように記載されたファイルができているか確認してください。

requirements.txtdj-database-url==0.5.0 Django==2.1 django-bootstrap4==0.0.8 gunicorn==19.9.0 psycopg2-binary==2.8.3 PyMySQL==0.9.3 pytz==2019.1 sqlparse==0.3.0 whitenoise==3.3.1 psycopg2==2.7.6.1 ?上で「psycopg2」がインストールできなかった人は追加(2-6)「runtime.txt」を新規作成

これは、CotEditorなり、普通のテキストエディタなりを開いて以下の1行を書きこんで保存してください。(このファイルは、Procfile同様に1行だけ)

保存場所は上の最初の画像を参照。

pythonのバージョンは自分が使用しているものに置き換えてください。

ただし、python2は想定していません。ご了承ください。python-3.7.3(3)「local_settings.py」を新規作成

settings.pyのデータベース接続部分をコピーして、新たに作成する「local_settings.py」に貼り付けします。(このファイルの保存場所は上の画像を確認してください。)

①settings.pyからDATABASEの部分をコピーする(DATABASEの部分は人によって異なると思います。)

②local_settings.pyという名前で新たに作成したファイルに、貼り付け(下のような感じになります。少しも省略していないため、local_settings.pyはこれが全てです。)

「?」の部分以外は人によって異なると思います。(Django2, MySQL, phpMyAdminの組み合わせの人は、

"NAME": "kiitedb",以外は下と全く同じになっても不思議ではありません。)local_settings.py#この上には何もありません import os ? BASE_DIR = os.path.dirname(os.path.dirname(os.path.abspath(__file__))) ? import pymysql pymysql.install_as_MySQLdb() DATABASES = { 'default': { #'ENGINE': 'django.db.backends.sqlite3', #'NAME': os.path.join(BASE_DIR, 'db.sqlite3'), "ENGINE": "django.db.backends.mysql", "NAME": "kiitedb",?ここは人によって違う "USER": "root",?場合によっては違う "PASSWORD": "root",?場合によっては違う "HOST": "127.0.0.1", "PORT": "3306", } } DEBUG = True ? #この下には何もありません「.gitignore」に「local_settings.py」を追加

先ほど作成した、「.gitignore」に「local_settings.py」の1行を追加してください。

.gitignoredj __pycache__ staticfiles local_settings.py ?追加 db.sqlite3 *.py[co](4)「settings.py」を編集する(4ステップ)

(4−1)ステップ1

下のコードを、settings.pyの一番下に貼り付けてください。

"@@@@@@@@@@"の部分は自分のパソコンのユーザー名に変更してください。settings.py#この上は省略してあります STATIC_URL = '/static/'?(静的ファイルがある方のみ) STATIC_ROOT = os.path.join(BASE_DIR, 'kiite/static')?kiiteの部分は自分のアプリ名(静的ファイルがある方のみ) from socket import gethostname hostname = gethostname() if "@@@@@@@@@@" in hostname: # デバッグ環境 DEBUG = True #=====ここから...===== import pymysql pymysql.install_as_MySQLdb() DATABASES = { 'default': { #'ENGINE': 'django.db.backends.sqlite3', #'NAME': os.path.join(BASE_DIR, 'db.sqlite3'), "ENGINE": "django.db.backends.mysql", "NAME": "kiitedb",?ここは人によって違う "USER": "root",?場合によっては違う "PASSWORD": "root",?場合によっては違う "HOST": "127.0.0.1", "PORT": "3306", } } #=====...ここまでは、使用しているデータベースに置き換えてください。===== ALLOWED_HOSTS = [] else: # 本番環境 DEBUG = True LOGGING = { 'version': 1, 'disable_existing_loggers': False, 'handlers': { 'console': { 'class': 'logging.StreamHandler', }, }, 'loggers': { 'django': { 'handlers': ['console'], 'level': os.getenv('DJANGO_LOG_LEVEL', 'DEBUG'), }, }, } # DB設定 import dj_database_url PROJECT_ROOT = os.path.dirname(os.path.abspath(__file__)) db_from_env = dj_database_url.config() DATABASES = { 'default': dj_database_url.config() } ALLOWED_HOSTS = ['*'] #この下には何もありません(4−2)ステップ2

WSGI_APPLICATION = '<プロジェクトネーム>.wsgi.application'を探して、その下に下記のコードを貼り付けsettings.pyimport dj_database_url db_from_env = dj_database_url.config() DATABASES = { 'default': dj_database_url.config() }(4−3)ステップ3

MIDDLEWAREを探して、下の1行を追加してください。settings.pyMIDDLEWARE = [ 'django.middleware.security.SecurityMiddleware', 'whitenoise.middleware.WhiteNoiseMiddleware',?この1行だけを追加 'django.contrib.sessions.middleware.SessionMiddleware',(4−4)ステップ4

下のように変更(最初からなっている人も多いと思いますが、一応)

settings.pyALLOWED_HOSTS = ["*"](5)「wsgi.py」を編集

「wsgi.py」を下記のコードに変えてください。(追記ではなく、全変えです。)

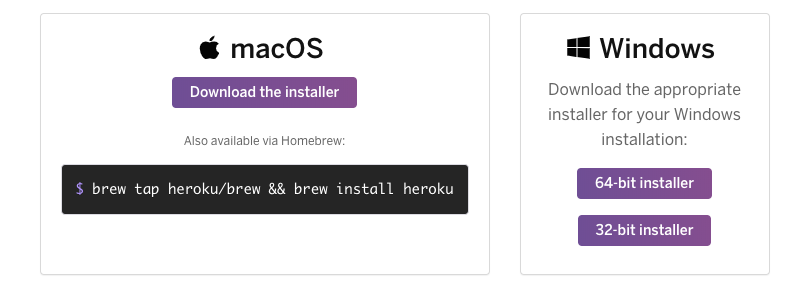

wsgi.py#この上には何もありません import os from django.core.wsgi import get_wsgi_application os.environ.setdefault('DJANGO_SETTINGS_MODULE', 'myapp7.settings')?myapp7は自分のアプリ名に変更 application = get_wsgi_application() from whitenoise.django import DjangoWhiteNoise application = DjangoWhiteNoise(application) #この下には何もありません(6)「Heroku CLI」をインストール

ここからインストールしてください。

インストーラーを起動後、「OK」や「完了」を押して、次々に進んでいけば大丈夫だと思います。

(7)デプロイ

下のコマンドをデプロイするアプリがある開発環境で順番に実行。

myapp7やkiiteは適宜変更してください。terminal(dj)$ cd myapp7 ?外側のディレクトリに移動 (cd)myapp7 $ git init ?「.git」ディレクトリが作成される (cd)myapp7 $ git config user.name <自分の名前> ?<>はいらない (cd)myapp7 $ git config user.email *+*+*+@info.com (cd)myapp7 $ git add -A . (cd)myapp7 $ git commit -m "First Django App, OK" (cd)myapp7 $ heroku login ?Herokuアカウントは事前に作成しておいてください (cd)myapp7 $ heroku create kiite ?kiiteは自由に変更(省略も可能) (cd)myapp7 $ git push heroku master (cd)myapp7 $ heroku ps:scale web=1 (cd)myapp7 $ heroku run python manage.py migrate (cd)myapp7 $ heroku run python manage.py createsuperuser (cd)myapp7 $ heroku open終了

参考サイト

- 投稿日:2019-06-27T15:49:44+09:00

Azure Databricks: 4. PySpark基本操作

サンプルデータセット

今回はkaggleのデータセット「Brazilian E-Commerce Public Dataset by Olist」をサンプルとして、Azure Databricksを使ったSparkの操作を行っていきます。

このデータはOlist StoreというブラジルのECサイトで行われた2016年から2018年までの約10万件の注文に関するデータが含まれています。

データ量としてはビッグデータというほどに多くありませんが、注文の商品明細やレビューなどが複数のCSVに分かれて保存され、それぞれがIDで紐づけられているため、PySparkやSpark SQLの練習に適しています。CSVの読み込み

注文ごとの商品の明細情報「olist_order_items_dataset.csv」を使ってデータの読み込みとPySparkの操作を行っていきます。

DataFrameに読み込み

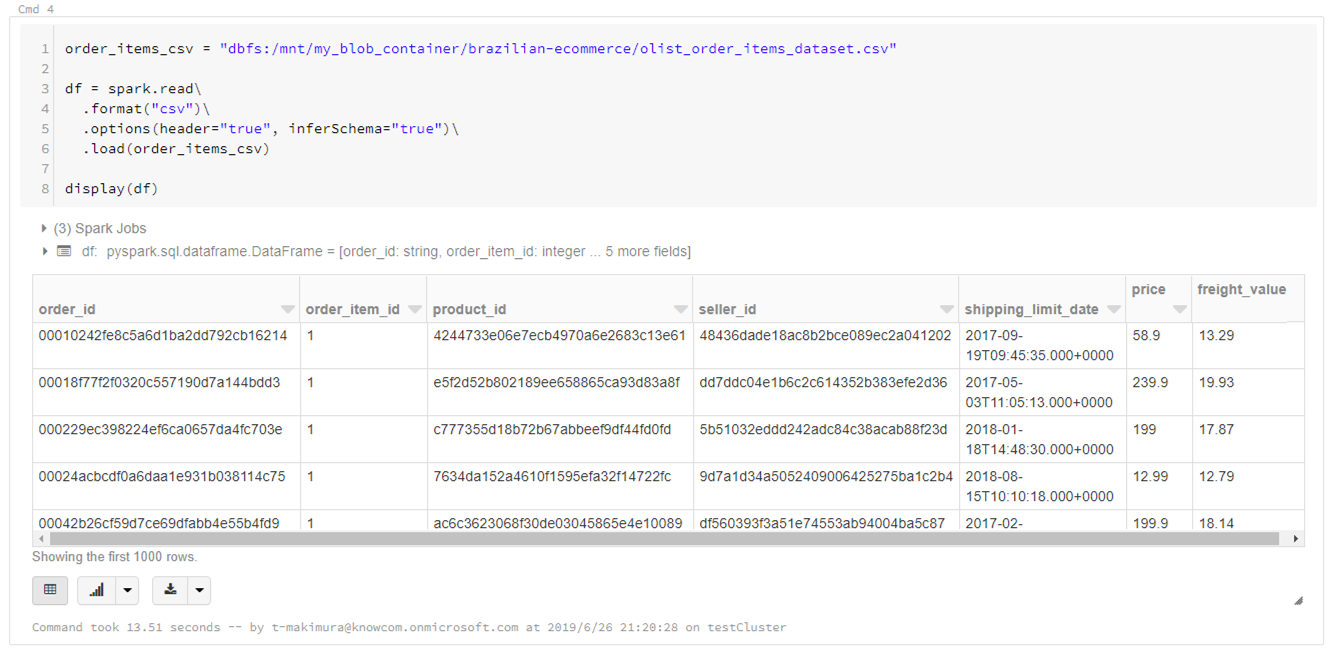

下記スクリプトでCSVをSpark DataFrameとして読み込みます。

読み込むCSVはカラム名を示す行が先頭にあるため、読み込みオプションとして「header="true"」、またカラムのデータ型を自動推定するため「inferSchema="true"」として読み込んでいます。

(※CSV読み込みオプションの詳細はDatabricksドキュメントも参照してください)order_items_csv = "dbfs:/mnt/my_blob_container/brazilian-ecommerce/olist_order_items_dataset.csv" df = spark.read\ .format("csv")\ .options(header="true", inferSchema="true")\ .load(order_items_csv) display(df)スキーマを指定して読み込み

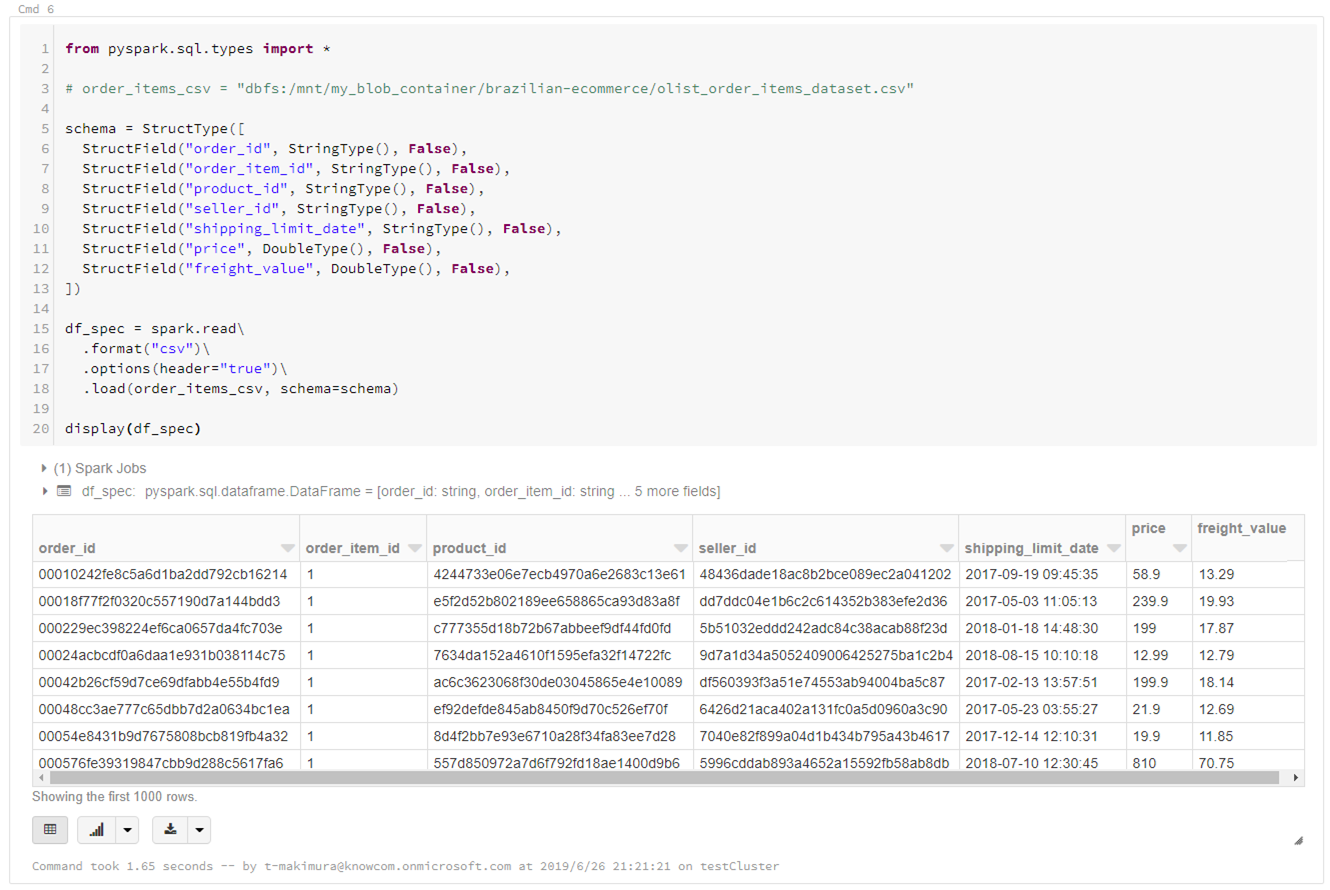

スキーマを指定して読み込みを行う場合は下記のようにします。

※指定できる型はSparkドキュメントも参照カラムのデータ型指定にinferSchemaを使用した場合、型推定のため1回余計に読み込むことになり、読み込みのパフォーマンスが低下します。

データのスキーマがわかっている場合は、スキーマを指定して読み込むことを推奨します。from pyspark.sql.types import * # order_items_csv = "dbfs:/mnt/my_blob_container/brazilian-ecommerce/olist_order_items_dataset.csv" # スキーマ指定 schema = StructType([ StructField("order_id", StringType(), False), StructField("order_item_id", StringType(), False), StructField("product_id", StringType(), False), StructField("seller_id", StringType(), False), StructField("shipping_limit_date", StringType(), False), StructField("price", DoubleType(), False), StructField("freight_value", DoubleType(), False), ]) df_spec = spark.read\ .format("csv")\ .options(header="true")\ .load(order_items_csv, schema=schema) display(df_spec)データ型の確認

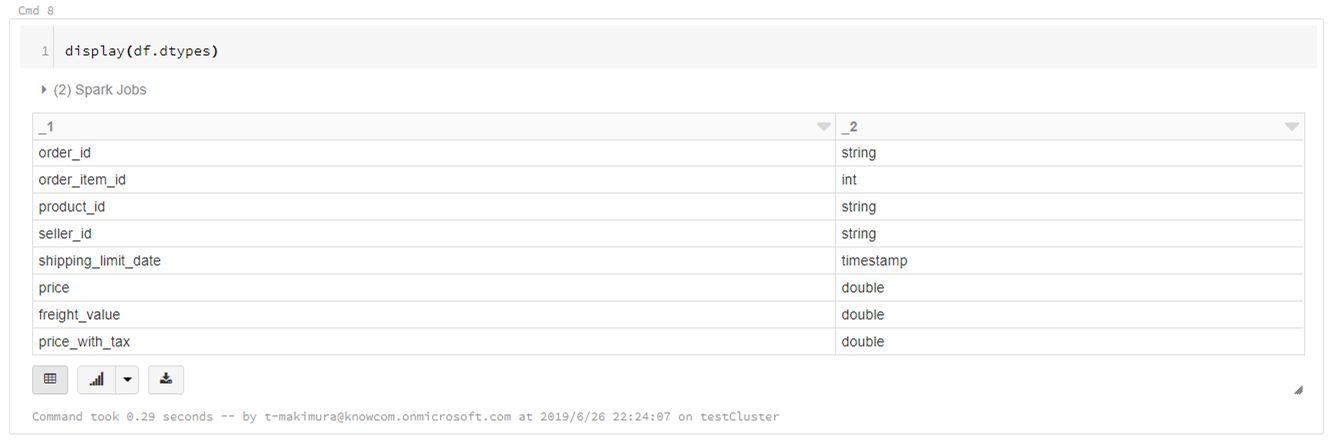

display(df.dtypes)PySparkでのDataFrameの基本操作

読み込んだCSVでPySparkの基本操作を実行します。

- 指定行数抽出して表示

display(df.head(5))

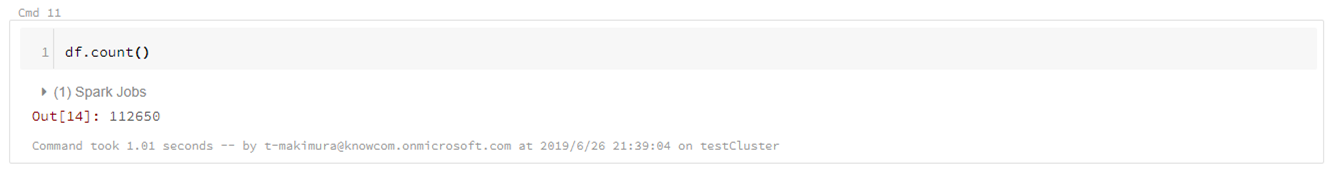

- 全レコード数のカウント

df.count()

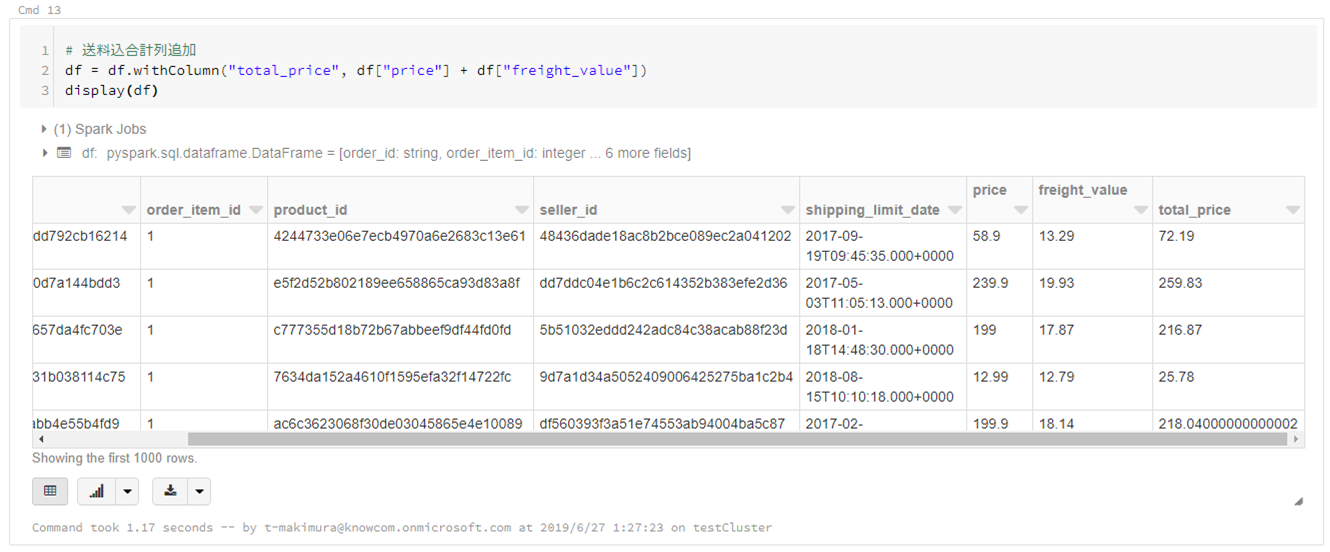

- 計算列の追加

# 送料込合計列追加 df = df.withColumn("total_price", df["price"] + df["freight_value"]) display(df)

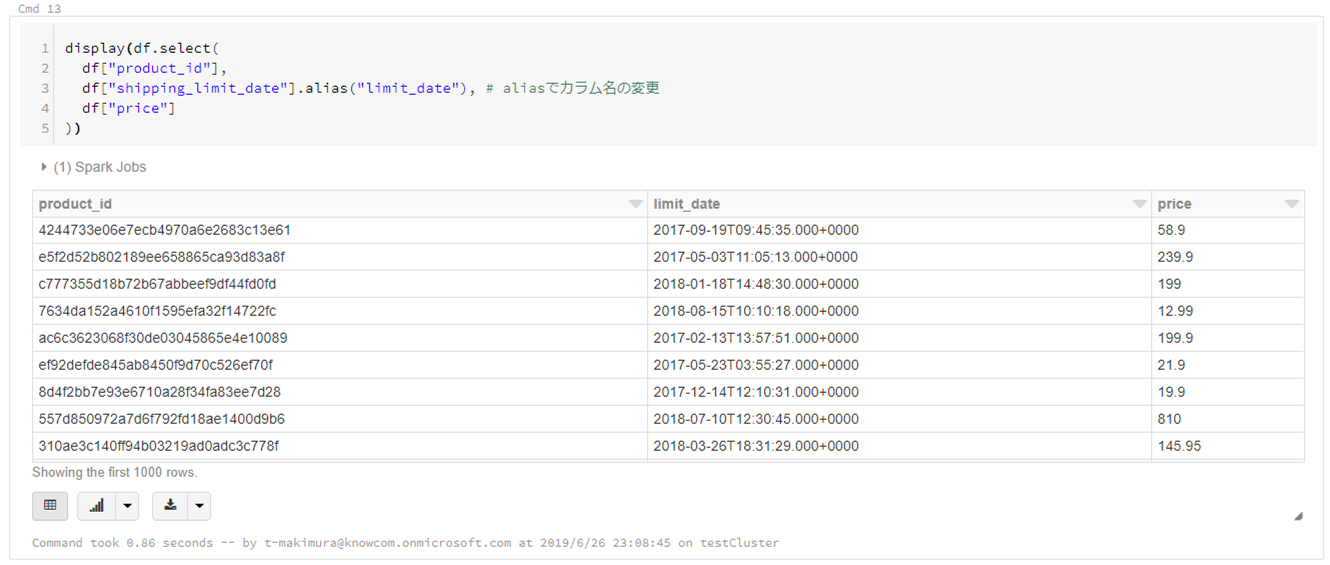

- カラムを指定して抽出

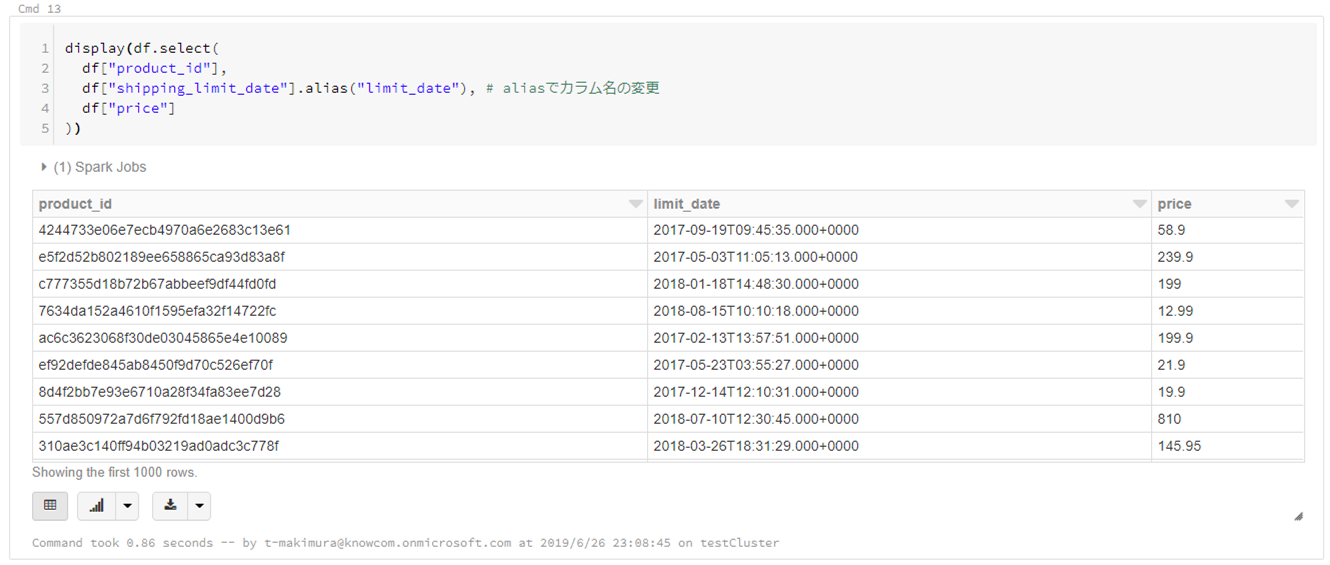

display(df.select( df["product_id"], df["shipping_limit_date"].alias("limit_date"), # aliasでカラム名の変更が可能 df["price"] ))

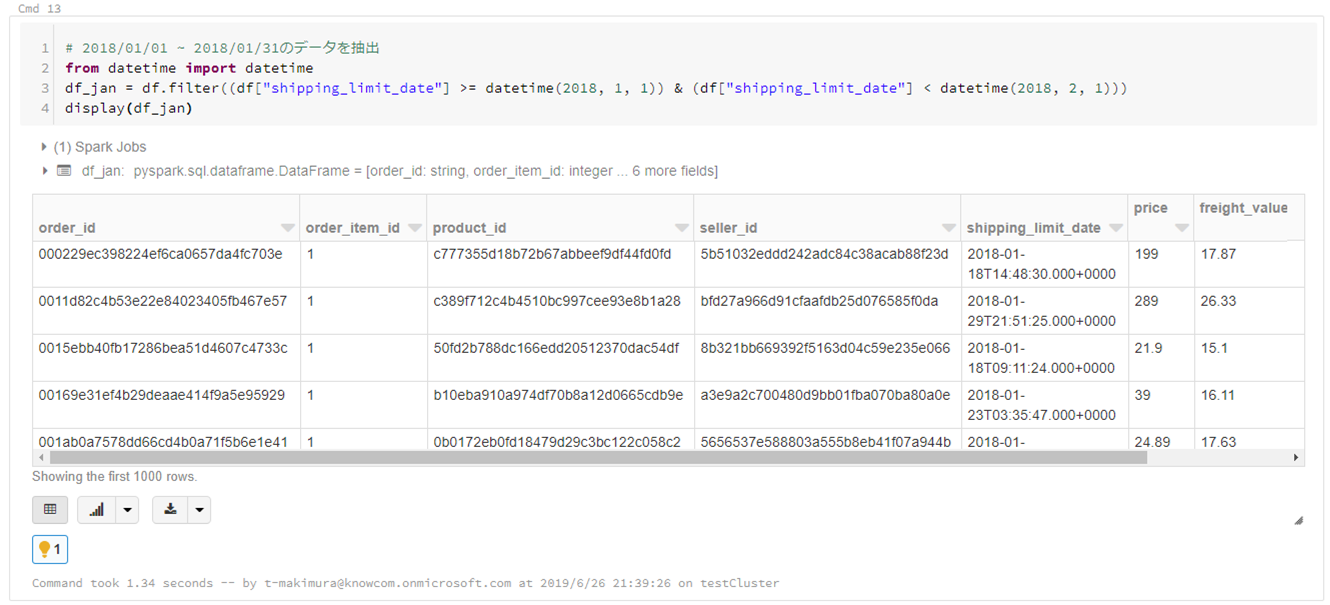

- 条件でレコード抽出

# 2018/01/01 ~ 2018/01/31のデータを抽出 from datetime import datetime df_jan = df.filter((df["shipping_limit_date"] >= datetime(2018, 1, 1)) & (df["shipping_limit_date"] < datetime(2018, 2, 1))) display(df_jan)

- レコードのカウント

# product_idごとの売り上げの個数 df_count = df_jan.groupBy("product_id").count() display(df_count)

- レコードの集計

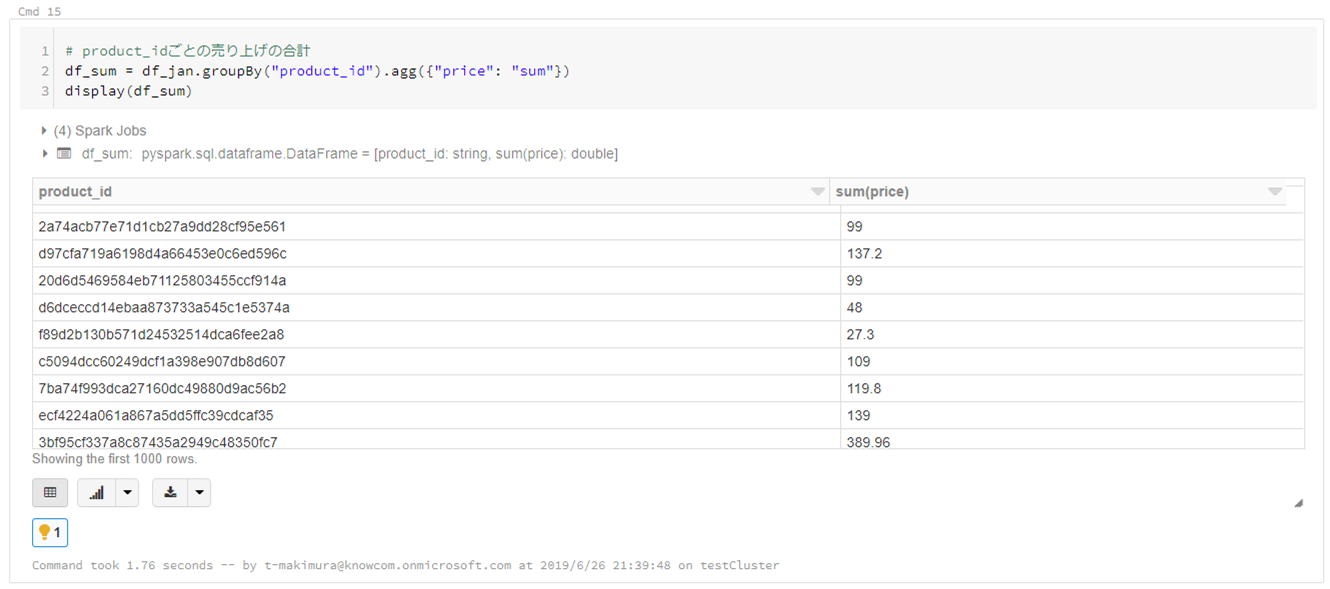

# product_idごとの売り上げの合計 df_sum = df_jan.groupBy("product_id").agg({"price": "sum"}) display(df_sum)Spark SQLを使用した操作

DataFrameをTemp Tableに登録することでSpark SQLを使用した集計が可能になります。

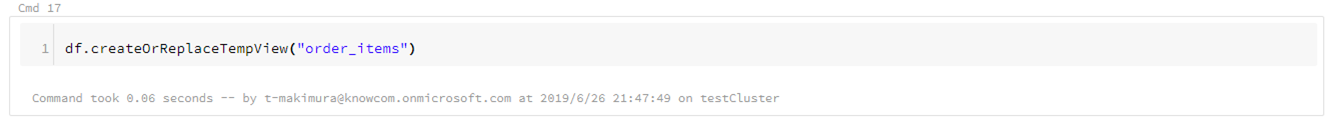

- Temp Tableの登録

df.createOrReplaceTempView("order_items")

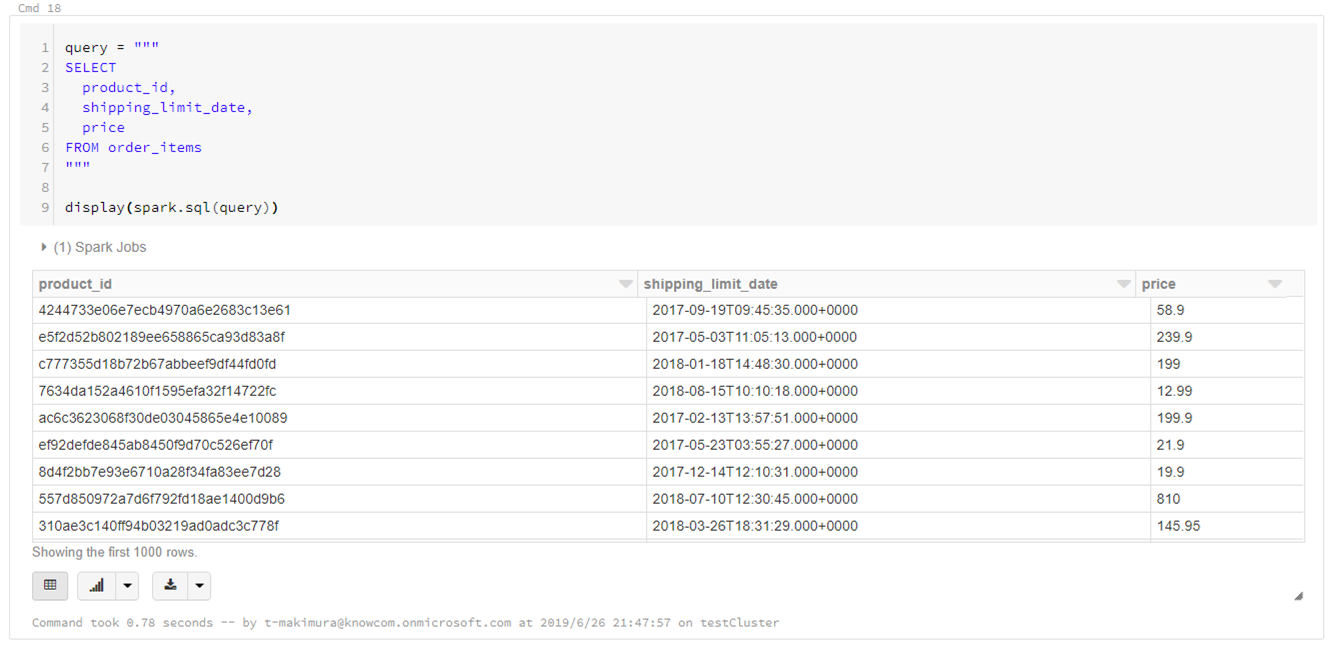

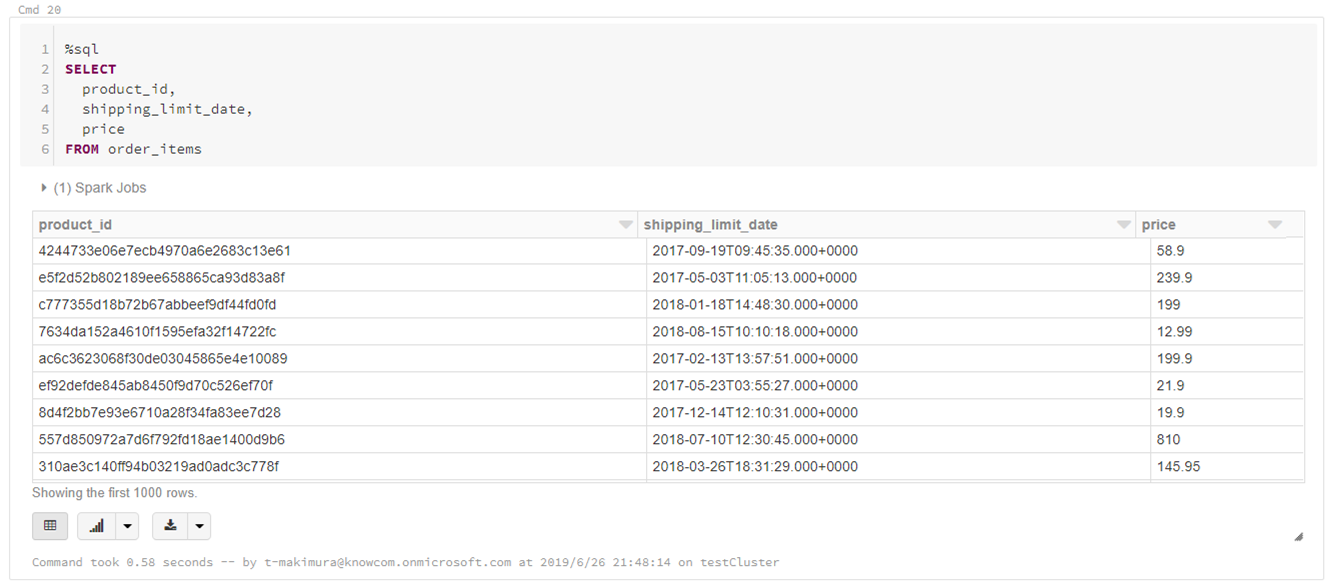

- Spark SQLによるカラム抽出

query = """ SELECT product_id, shipping_limit_date, price FROM order_items """ display(spark.sql(query))

- %sqlマジックコマンドを使用する場合

%sql SELECT product_id, shipping_limit_date, price FROM order_itemsDataFrameの結合

データセットに含まれる他のCSVファイルと組み合わせて商品カテゴリごとの売り上げを集計してみます。

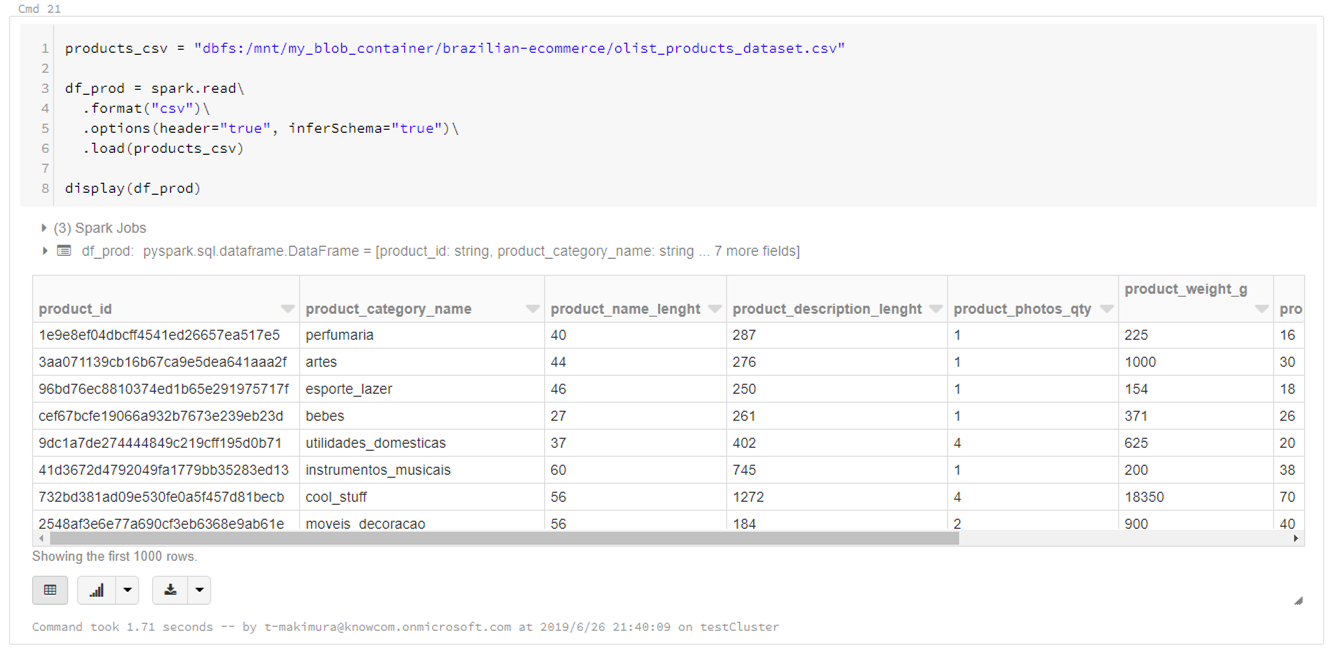

各商品の詳細情報「olist_products_dataset.csv」をDataFrameに読み込みます。

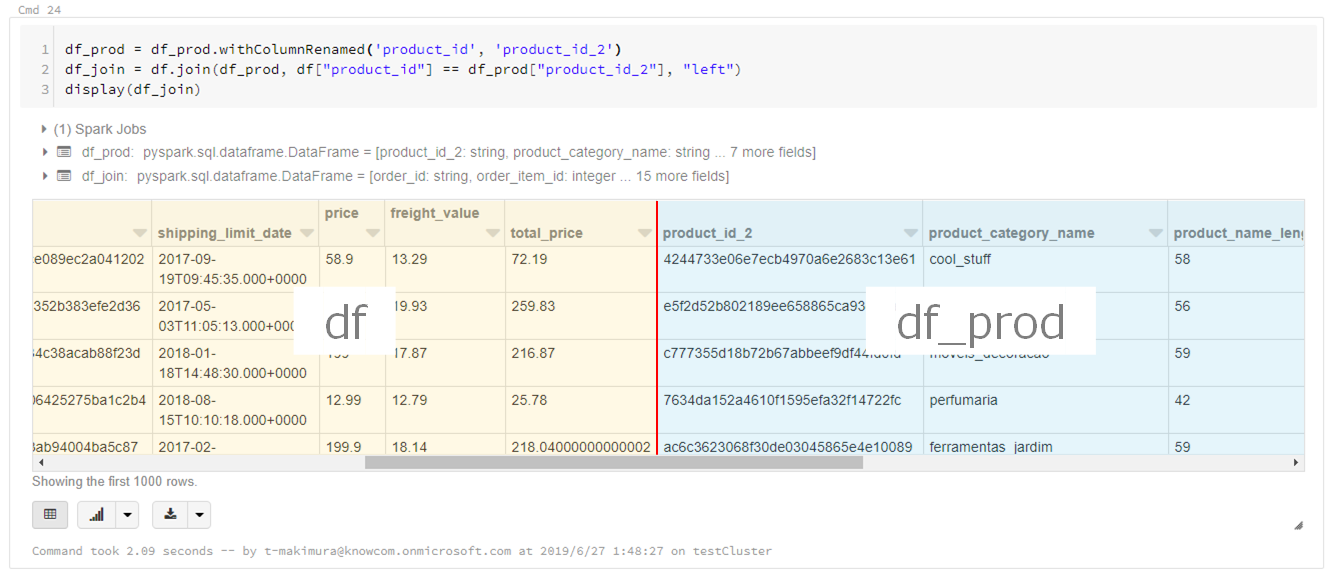

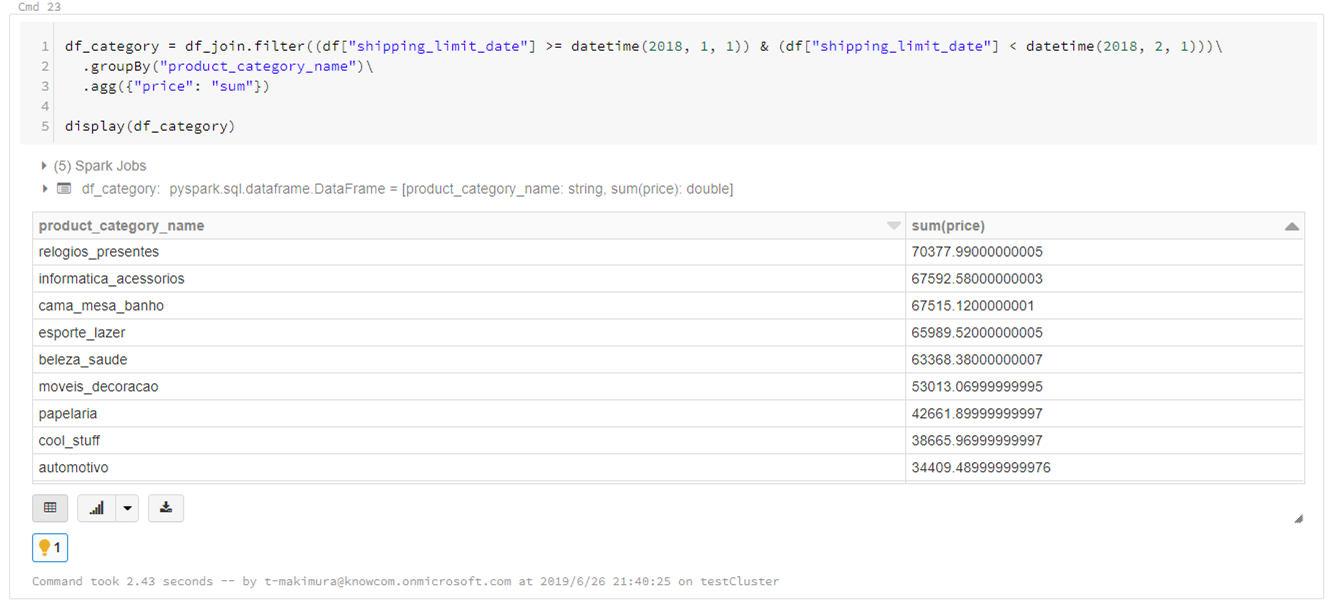

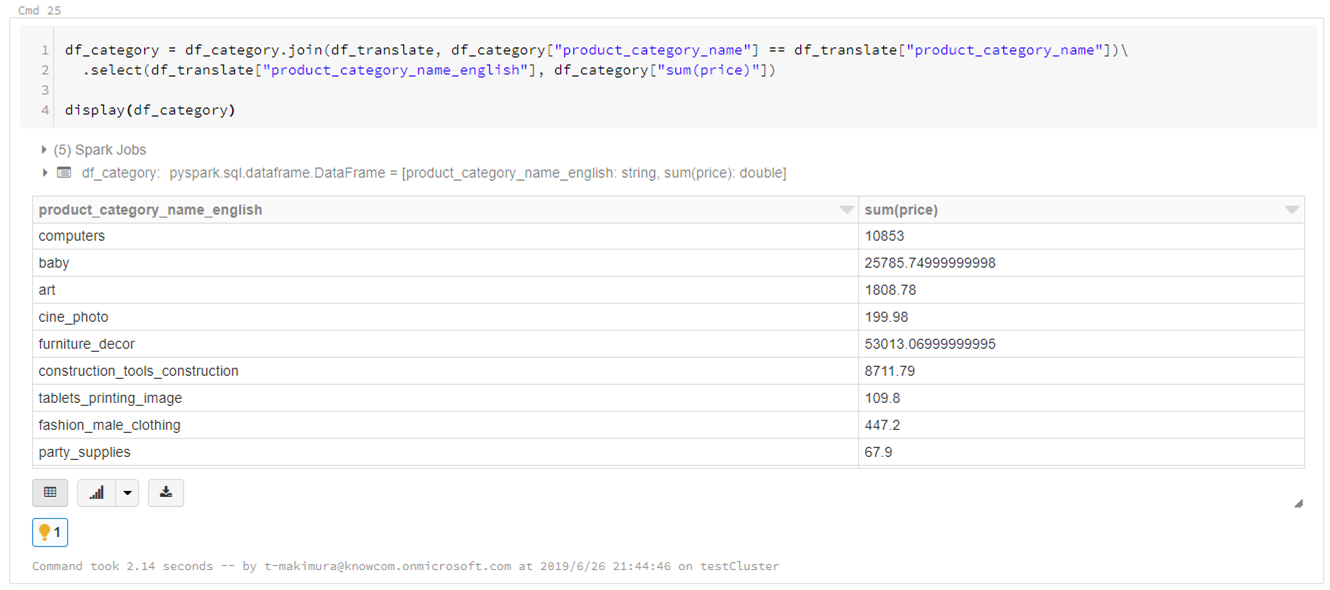

products_csv = "dbfs:/mnt/my_blob_container/brazilian-ecommerce/olist_products_dataset.csv" df_prod = spark.read\ .format("csv")\ .options(header="true", inferSchema="true")\ .load(products_csv) display(df_prod)# カラム名の変更 df_prod = df_prod.withColumnRenamed("product_id", "product_id_2") # DataFrame結合 df_join = df.join(df_prod, df["product_id"] == df_prod["product_id_2"]) display(df_join)2018年1月の商品カテゴリごとの売り上げ金額を集計します。

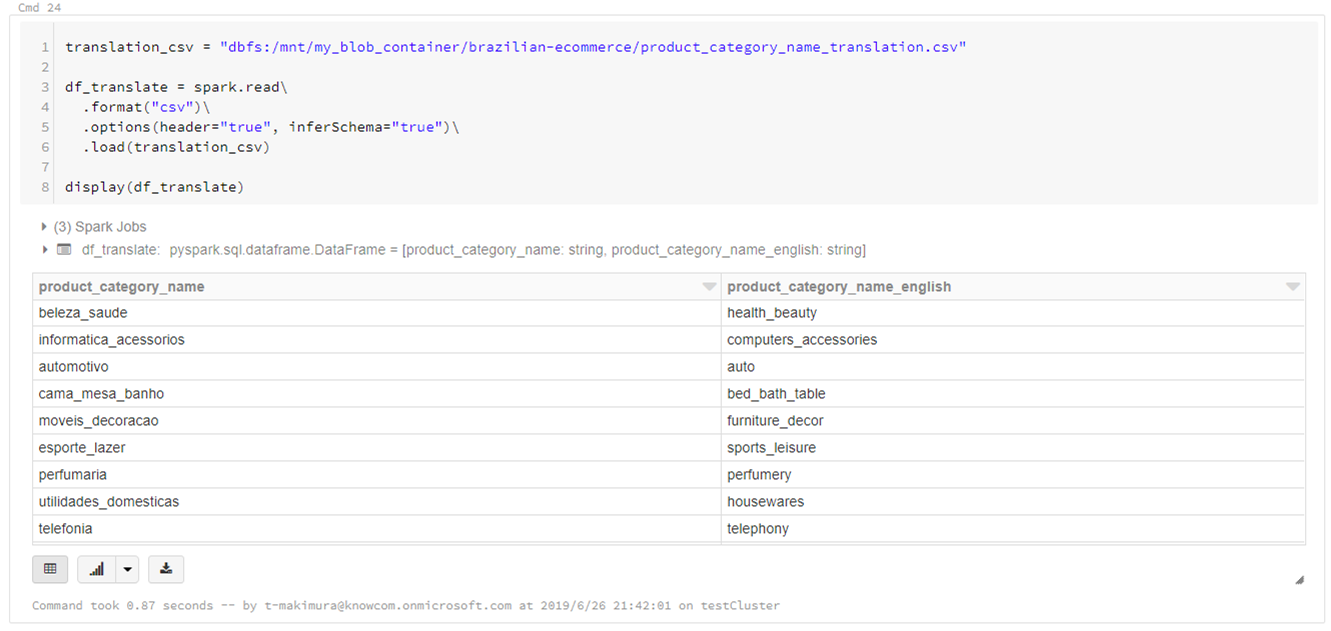

「sum(price)」をソートすると「relogios_presentes」の売り上げが最も高いことがわかりますが、ポルトガル語なので何の商品カテゴリかわかりません。df_category = df_join.filter((df["shipping_limit_date"] >= datetime(2018, 1, 1)) & (df["shipping_limit_date"] < datetime(2018, 2, 1)))\ .groupBy("product_category_name")\ .agg({"price": "sum"}) display(df_category)データセットにカテゴリを英語翻訳したCSVファイルがあるため、これも読み込みます。

translation_csv = "dbfs:/mnt/my_blob_container/brazilian-ecommerce/product_category_name_translation.csv" df_translate = spark.read\ .format("csv")\ .options(header="true", inferSchema="true")\ .load(translation_csv) display(df_translate)結合して翻訳します。

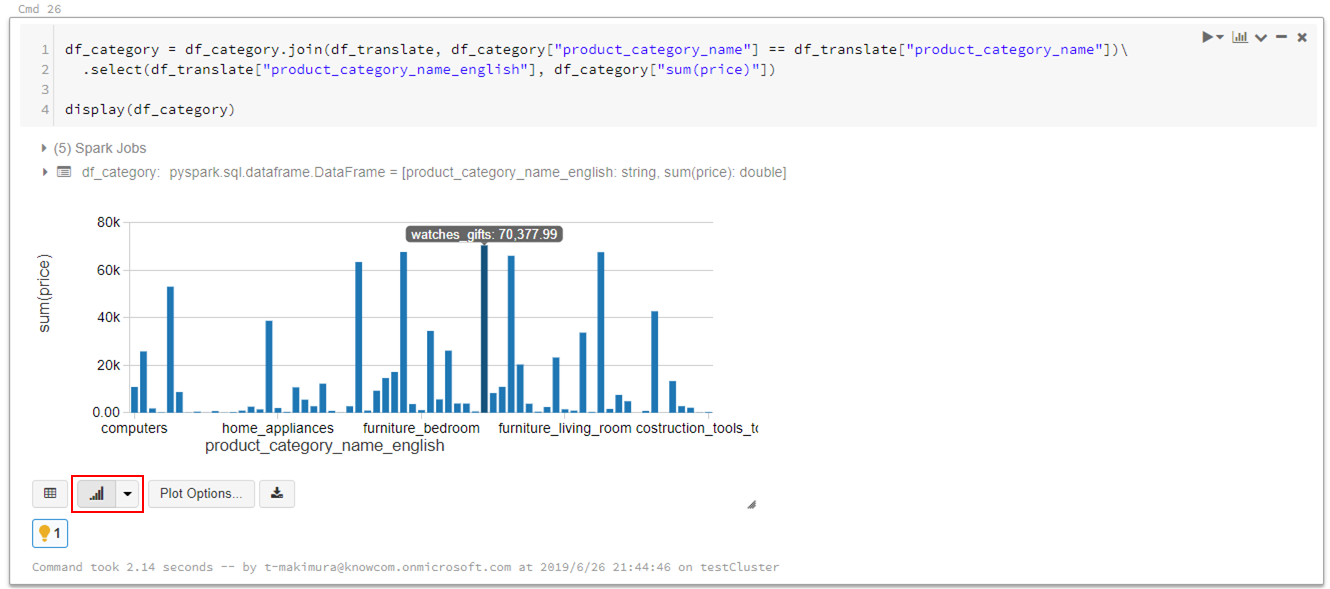

df_category = df_category.join(df_translate, df_category["product_category_name"] == df_translate["product_category_name"])\ .select(df_translate["product_category_name_english"], df_category["sum(price)"]) display(df_category)Databricksではデータの可視化も簡単にできます。

売り上げが最も高いのは「watches_gifts」であることがわかりました。

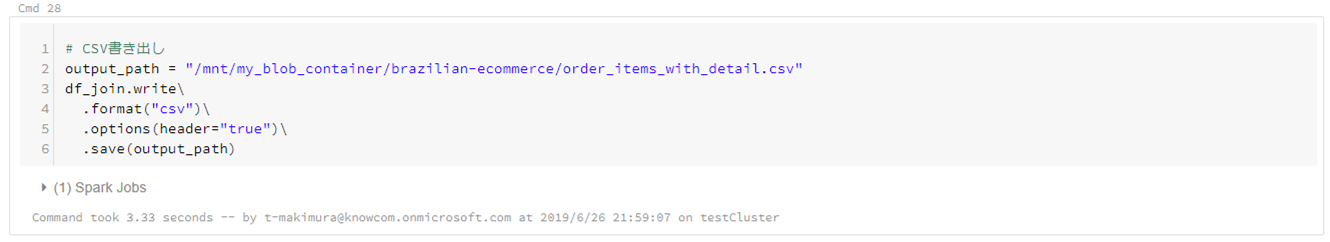

CSVの書き出し

DataFrameを書き出す場合は下記コマンドを使用します。

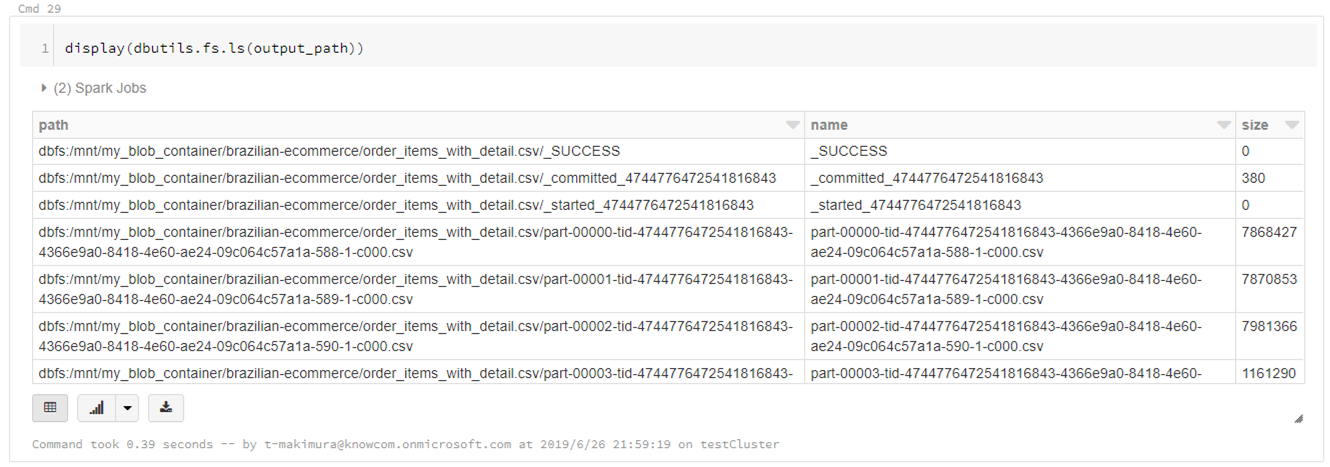

# DataFrameCSV書き出し output_path = "/mnt/my_blob_container/brazilian-ecommerce/order_items_with_detail.csv" df.join.write\ .format("csv")\ .options(header="true")\ .save(output_path)CSVは指定したパスに直接書き出されるのではなく、指定パスのディレクトリが作成され、直下に分割されたCSVファイルとして出力されます。

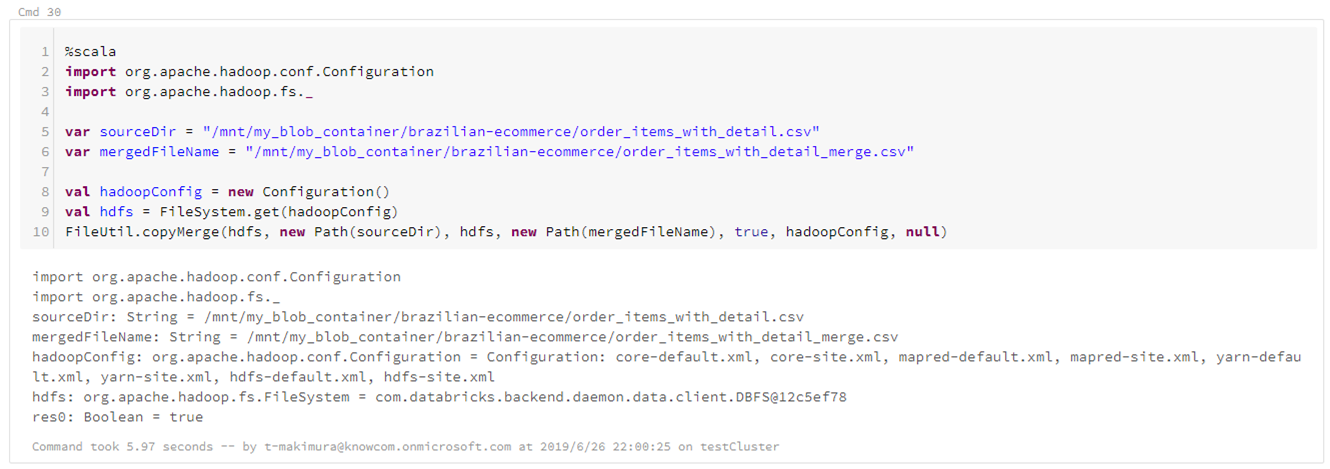

display(dbutils.fs.ls(output_path))ファイルを1つのCSVとして出力する場合は、HadoopのFileUtil.copyMergeを使用し、上記で出力したファイルをマージして1ファイルにまとめます。

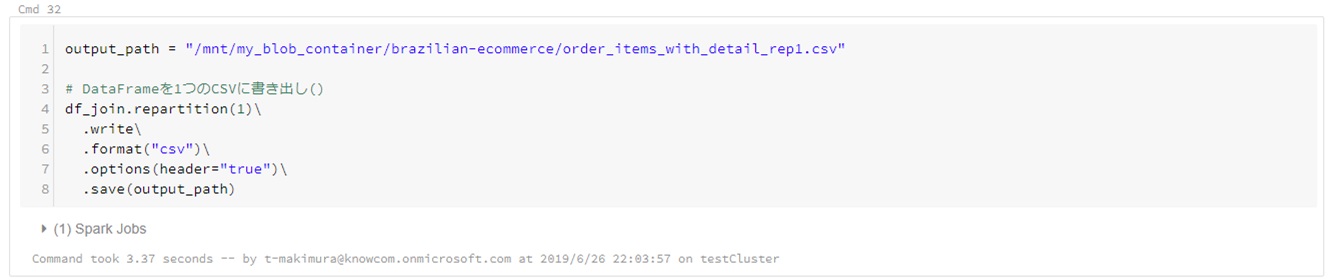

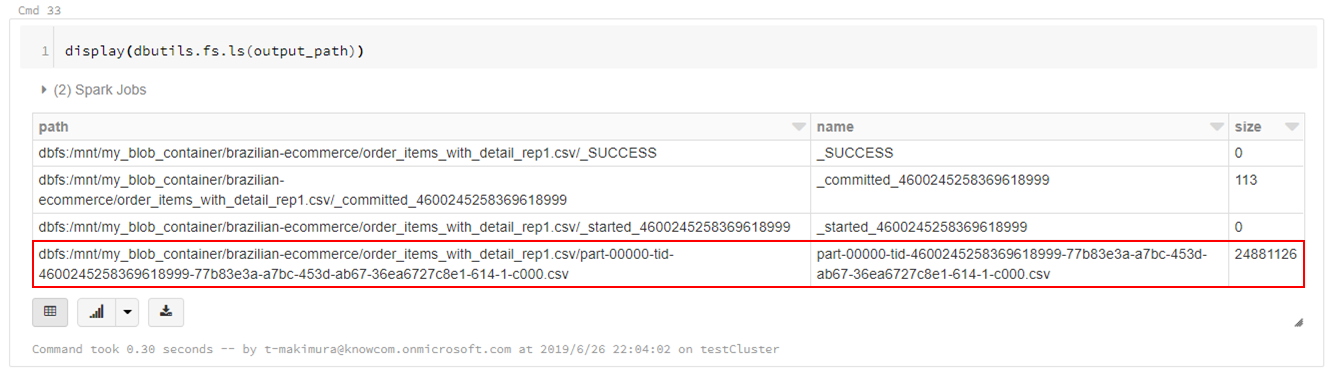

%scala import org.apache.hadoop.conf.Configuration import org.apache.hadoop.fs._ var sourceDir = "/mnt/blob_container/output.csv" var mergedFileName = "/mnt/blob_container/output_merge.csv" val hadoopConfig = new Configuration() val hdfs = FileSystem.get(hadoopConfig) FileUtil.copyMerge(hdfs, new Path(sourceDir), hdfs, new Path(mergedFileName), true, hadoopConfig, null)import os display(dbutils.fs.ls(os.path.dirname(output_path)))Clusterのメモリ量に余裕がある場合は、下記スクリプトで1ファイルにデータを書き出すことができます。