- 投稿日:2021-01-10T23:29:30+09:00

AtCoder Beginner Contest 188 参戦記

AtCoder Beginner Contest 188 参戦記

ABC188A - Three-Point Shot

2分で突破. 書くだけ.

X, Y = map(int, input().split()) if Y < X: X, Y = Y, X if X + 3 > Y: print('Yes') else: print('No')ABC188B - Orthogonality

2分で突破. 書くだけ.

N = int(input()) A = list(map(int, input().split())) B = list(map(int, input().split())) if sum(a * b for a, b in zip(A, B)) == 0: print('Yes') else: print('No')ABC188C - ABC Tournament

7分で突破. N≤16 なので、素直にトーナメントを実行しても O(217) で TLE しないので、素直にやって AC.

N, *A = map(int, open(0).read().split()) a = range(2 ** N) while len(a) != 2: t = [] for i in range(0, len(a), 2): if A[a[i]] > A[a[i + 1]]: t.append(a[i]) else: t.append(a[i + 1]) a = t if A[a[0]] > A[a[1]]: print(a[1] + 1) else: print(a[0] + 1)コンテスト後に、山を真ん中で2つに分けて、一番強いやつがいない側の一番強いやつが準優勝だから、サクッと解けるなと気づいた.

N, *A = map(int, open(0).read().split()) i = A.index(max(A)) if i < 2 ** (N - 1): print(A.index(max(A[:2 ** (N - 1)]) + 1) else: print(A.index(max(A[2 ** (N - 1):]) + 1)ABC188D - Snuke Prime

13分で突破. 問題文を見た瞬間に imos 法一発じゃんラッキーと思ったが bi≤109 を見て憤死した. 辞書で imos 法をするのを脳内シミュレーションしたら全然問題ないことに気づいて驚きつつ AC. 座圧でも良かったらしい. 後で座圧でも解こう.

from sys import stdin readline = stdin .readline N, C = map(int, readline().split()) d = {} for _ in range(N): a, b, c = map(int, readline().split()) d.setdefault(a, 0) d[a] += c d.setdefault(b + 1, 0) d[b + 1] -= c skeys = sorted(d) for i in range(1, len(skeys)): d[skeys[i]] += d[skeys[i - 1]] for k in d: if d[k] > C: d[k] = C result = 0 for i in range(len(skeys) - 1): result += d[skeys[i]] * (skeys[i + 1] - skeys[i]) print(result)追記: 座標圧縮+imos法で解いてみた.

from sys import stdin from itertools import accumulate readline = stdin .readline N, C = map(int, readline().split()) abc = [tuple(map(int, readline().split())) for _ in range(N)] p = set() for a, b, _ in abc: p.add(a) p.add(b) p.add(b + 1) inv = sorted(p) fwd = {} for i in range(len(inv)): fwd[inv[i]] = i t = [0] * len(inv) for a, b, c in abc: t[fwd[a]] += c t[fwd[b + 1]] -= c t = list(accumulate(t)) result = 0 for i in range(len(t) - 1): result += min(t[i], C) * (inv[i + 1] - inv[i]) print(result)追々記: 解説に書かれている方法で解いてみた. うーん、スマート.

from sys import stdin readline = stdin .readline N, C = map(int, readline().split()) q = [] for _ in range(N): a, b, c = map(int, readline().split()) q.append((a, c)) q.append((b + 1, -c)) result = 0 p = 0 ac = 0 for x, y in sorted(q): result += min(C, ac) * (x - p) p = x ac += y print(result)ABC188E - Peddler

67分で突破. WA2. 問題文を読んだ瞬間に後ろからやっていけばいいと分かったけど、何故か行けるところ管理に Union Find を使って自爆.

from sys import stdin readline = stdin.readline N, M = map(int, readline().split()) A = list(map(int, readline().split())) links = [[] for _ in range(N)] for _ in range(M): X, Y = map(lambda x: int(x) - 1, readline().split()) links[X].append(Y) maxvs = [None] * N result = -(10 ** 18) for i in range(N - 1, -1, -1): if len(links[i]) == 0: maxvs[i] = A[i] continue maxv = max(maxvs[j] for j in links[i]) result = max(result, maxv - A[i]) maxvs[i] = max(maxv, A[i]) print(result)ABC188F - +1-1x2

WA2 まで行ったものの突破できず. Greedy じゃなくてメモ化再帰でやればよかったのか. (Y-1)÷2 を優先していたが、(Y+1)÷2 のほうが良かったことがあったようだ. Xを変化させるのではなく、Yを変化させたほうがいいというのはどこかで似たような問題をやって知ってた.

from functools import lru_cache X, Y = map(int, input().split()) @lru_cache(maxsize=None) def f(y): if X >= y: return abs(X - y) if y % 2 == 0: return min(abs(y - X), f(y // 2) + 1) else: return min(abs(y - X), f((y - 1) // 2) + 2, f((y + 1) // 2) + 2) print(f(Y))

- 投稿日:2021-01-10T23:24:18+09:00

pyenv + conda の環境構築メモ

はじめに

anacondaを直接インストールすると,Homebrewと衝突してしまうらしいので,pyenv + condaでanaconda環境を構築しました.

インストール方法(pyenvインストール済みの状態)

インストール可能なanacondaの検索

pyenv install -l | grep anacondaインストール

pyenv install anaconda3-2020.07condaによる仮想環境の作り方

anacondaをglobalに切り替え

pyenv global anaconda3-2020.07仮想環境の作成

conda create -n [仮想環境名] python=[pythonのバージョン] [installしたいライブラリ] [installしたいライブラリ] ...作業用のディレクトリでのみ作成した仮想環境を有効化

mkdir test_conda cd test_conda pyenv local [仮想環境名] # ディレクトリ内に.python-versionというファイルが生成される. # ディレクトリを抜けると, globalで有効化された環境に戻る作成した仮想環境をactivateで起動(フルパス指定)

conda activate [仮想環境名] # sourceで直接ファイルを実行してもおけ source $PYENV_ROOT/versions/anaconda3-2020.07/bin/activate [仮想環境名]起動中の仮想環境の停止

conda deactivateその他のコマンド

ライブラリのインストール

conda install [ライブラリ名]インストール済みのライブラリの表示

conda list仮想環境の削除

conda remove -n [仮想環境名] --all参考

- 投稿日:2021-01-10T23:21:58+09:00

Effective Python 学習備忘録 9日目 【9/100】

はじめに

Twitterで一時期流行していた 100 Days Of Code なるものを先日知りました。本記事は、初学者である私が100日の学習を通してどの程度成長できるか記録を残すこと、アウトプットすることを目的とします。誤っている点、読みにくい点多々あると思います。ご指摘いただけると幸いです!

今回学習する教材

- Effective Python

- 8章構成

- 本章216ページ

今日の進捗

- 進行状況:69-73ページ

- 第3章:クラスと継承

- 本日学んだことの中で、よく忘れるところ、知らなかったところを書いていきます。

親クラスをsuperを使って初期化する

子クラスから親クラスを初期化する方法

__init__メソッドを用いた初期化

- 問題点

- superを用いた初期化

__init__メソッドを用いた初期化# 親クラス class MyBaseClass(object): def __init__(self, value): self.value = value # 子クラス class MyChildClass(MyBaseClass): def __init__(self): MyBaseClass.__init__(self, 5) # 親クラスの__init__メソッドを呼びだし初期化

__init__メソッドを用いた初期化の問題点この方式は、単純な階層では問題なく動作しますが、多重継承によって、影響を受けている状態でスーパークラスの

__init__メソッドを直接呼び出すと、おかしな振る舞いを起こす場合があります。特に、ダイヤモンド継承の際に、予期せぬ振る舞いを起こします。

ダイヤモンド継承とは、サブクラスが2つの別々のクラスから継承し、かつその2つが継承改装で同じスーパークラスを持っていることを指します。例えば、MyBaseClassを継承する2つの子クラスとそれらを継承する子クラスを次のように定義します。# 親クラス class MyBaseClass(object): def __init__(self, value): self.value = value # 親クラスを継承する子クラス1 class TimesFive(MyBaseClass): def __init__(self, value): MyBaseClass.__init__(self, value) self.value *= 5 # 親クラスを継承する子クラス2 class PlusTwo(MyBaseClass): def __init__(self, value): MyBaseClass.__init__(self, value) self.value += 2 # 2つのクラスを継承する子クラス定義し、MyBaseClassをダイヤモンドの頂点に class ThisWay(TimesFive, PlusTwo): def __init__(self, value): TimesFive.__init__(self, value) PlusTwo.__init__(self, value) foo = ThisWay(5) print('Should be ( 5 * 5) + 2 = 27 but is', foo.value)出力結果

Should be ( 5 * 5) + 2 = 27 but is 7出力は、ThisWayの引数5がTimesFiveで5倍され、PlusTwoで2を加算し、27になるはずですが、7になっています。この原因は、PlusTwo.initの呼び出しで、MyBaseClass.initが2回目に呼び出されたところで5にリセットされるためです。Python3ではsuperを使うことでこの問題を解決することができます。また、Python3では常にsuperを使うべきです。

superを用いた初期化

class Explicit(MyBaseClass): def __init__(self, value): super(__class__, self).__init__(value * 2) class Implicit(MyBaseClass): def __init__(self, value): super().__init__(value * 2) print('Explicit', Explicit(10).value) print('Implicit', Implicit(10).value)出力結果

Explicit 20 Implicit 20まとめ

- Pythonの標準メソッド解決順序は、スーパークラスの初期化順序とダイヤモンド継承の問題を解決する

- 親クラスを初期化するには、常に組み込み関数superを使う

- 投稿日:2021-01-10T22:46:59+09:00

Pythonで学ぶアルゴリズム 第17弾:並べ替え(バブルソート)

#Pythonで学ぶアルゴリズム< バブルソート >

はじめに

基本的なアルゴリズムをPythonで実装し,アルゴリズムの理解を深める.

その第17弾として挿入ソートを扱う.バブルソート

一般に交換ソートいうとバブルソートを指す.

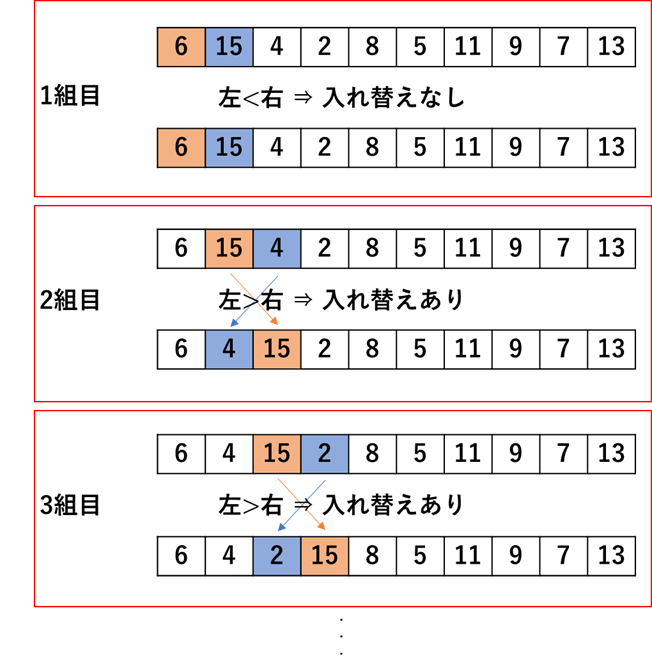

リストの隣り合ったデータを比較して,大小の順序が違っているときは並べていく.そのイメージ図を次に示す.

実装

先ほどの手順に従ったプログラムのコードとそのときの出力を以下に示す.

コード

bubble_sort.py""" 2021/01/10 @Yuya Shimizu バブルソート """ def bubble_sort(data): """バブルソート:前から2つずつデータを比較し並べ替える.""" for i in range(len(data)): for j in range(len(data) - i -1): if data[j] > data[j+1]: #左の方が大きい場合 data[j], data[j+1] = data[j+1], data[j] #前後入れ替え return data if __name__ == '__main__': DATA = [6, 15, 4, 2, 8, 5, 11, 9, 7, 13] sorted_data = bubble_sort(DATA.copy()) print(f"{DATA} → {sorted_data}")出力

[6, 15, 4, 2, 8, 5, 11, 9, 7, 13] → [2, 4, 5, 6, 7, 8, 9, 11, 13, 15]うまく入れ替えられているが,これでは比較入れ替えが途中で必要なくなったとしてもデータの数だけ必ず繰り返すことになる.その部分を省くために,一巡して入れ替えが行われなくなった場合,繰り返しを抜ける操作を付け加えた.そのコードと出力を以下に示す.

コード

bubble_sort_improved.py""" 2021/01/10 @Yuya Shimizu バブルソート(改良版) """ def bubble_sort(data): """バブルソート:前から2つずつデータを比較し並べ替える.ただし,交換がもう必要ない所は省略する""" change = True #交換の余地ありと仮定 for i in range(len(data)): if not change: #交換の余地無しで繰り返し脱出 break change = False #交換の余地無しと仮定 for j in range(len(data) - i -1): if data[j] > data[j+1]: #左の方が大きい場合 data[j], data[j+1] = data[j+1], data[j] #前後入れ替え change = True #交換の余地ありかも return data if __name__ == '__main__': DATA = [6, 15, 4, 2, 8, 5, 11, 9, 7, 13] sorted_data = bubble_sort(DATA.copy()) print(f"{DATA} → {sorted_data}")出力

[6, 15, 4, 2, 8, 5, 11, 9, 7, 13] → [2, 4, 5, 6, 7, 8, 9, 11, 13, 15]ちゃんと昇順に並べ替えられていることが分かる.

今回は並べ替える前後での比較をしたいがために,あえてsorted_dataという変数に結果を格納し,さらに関数への引数はDATA.copy()というようにcopy関数により,引数に影響が出ないようにしている.並べ替えるだけなら,そのような操作は必要でなく,bubble_sort(DATA)とすればよい.バブルソートの計算量

最後に計算量について触れる.

基本的に選択ソートと同様,計算量はオーダー記法で表すと,$O(n^2)$となる.

ただし,一度も交換が発生しない場合は,比較のみ(入れ替えなし)で済むため$O(n)$となる.

最悪時間計算量が$O(n^2)$であることに変わりはない.感想

前回に引き続き,そこまで複雑ではなかった.リスト内で一度に入れ替えを行うとき,一時的に値を保存する必要はなく,次のようにカンマで代入するだけでよいことを知った.これは大きなものを得られたと思う.

data[j+1], data[j] = data[j], data[j+1]次回以降の並べ替えアルゴリズムも楽しみである.

参考文献

Pythonで始めるアルゴリズム入門 伝統的なアルゴリズムで学ぶ定石と計算量

増井 敏克 著 翔泳社

- 投稿日:2021-01-10T22:34:25+09:00

[Python] Foliumのコロプレス図(Choropleth)でデータがないと黒くなる箇所を白くする

How to make black colored area in Folium Choropleth white where data is missing; simply set the nan_fill_color

この記事について

現在、Foliumのコロプレス図(Choropleth)を勉強中ですが、ネットに掲載されているものはきちんと動かないものが多く、苦労しています。そんな中、こちらのサイトのものはきちんと動作して、非常に参考になりました。

Pythonでビックマック指数のヒートマップ世界地図を作ってみる

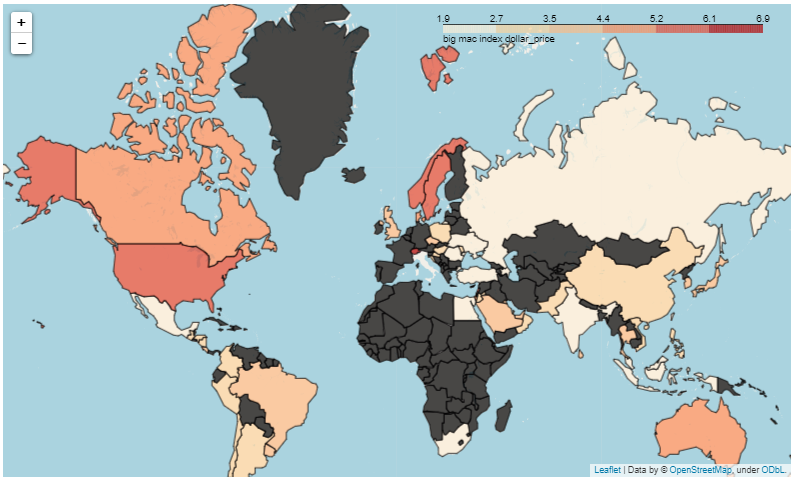

https://techray.hatenablog.com/entry/2019/12/16/200248しかし、表示される地図で、ビックマック指数がないところ(マクドナルドの店舗がないところ?!)は黒くなり、ちょっと見ずらいです。(厳密にはダークグレーですが、黒として進めます)

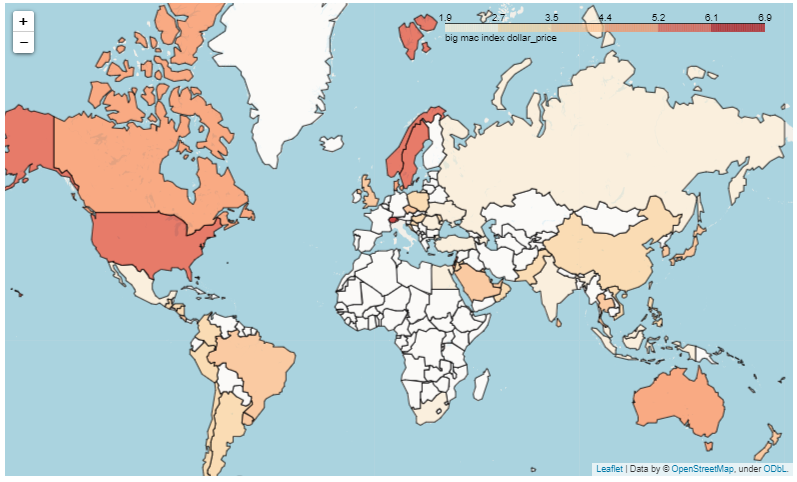

ちょっと、黒を白くしてみました!

こうしてみると、一番、ビッグマックが高いのはスイスであることが分かりやすかと思います。

何を変えたか

元のサイトに掲載されるデータはそちらで見ていただきたいのですが、以下、nan_fill_colorという箇所を1行追加しました。

# 地図に色を塗る folium.Choropleth( geo_data=geojson, name='choropleth', data=df,# 描画データ columns=['iso_a3', 'dollar_price'], # ["国コード", "値の列"] key_on='feature.id', fill_color='OrRd',# 色指定 fill_opacity=0.7, # 色の透明度 line_opacity=1,#国境線の透明度 nan_fill_color="white", #### ここでdfにない国は白にする!!! ##### legend_name='big mac index dollar_price' #凡例 ).add_to(m)これはFoliumのdocumentationに記載されていましたが、あまり知られていないようです。

https://python-visualization.github.io/folium/modules.htmlnan_fill_color (string, default 'black') – Area fill color for nan or missing values. Can pass a hex code, color name.

値のないものはNaN扱いとなり、その色を指定できるようです。

色を指示する他にも透明度を変えることもできるそうです。その他

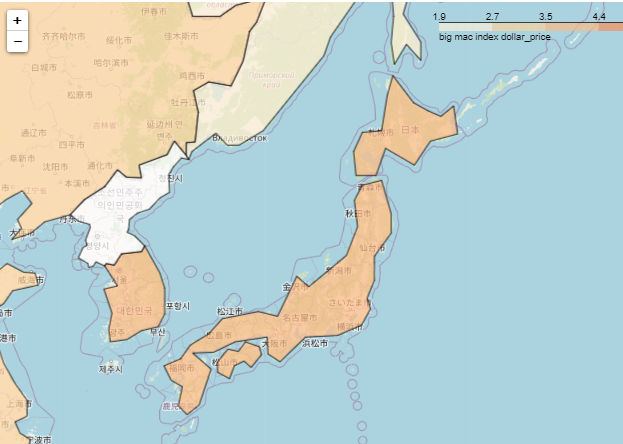

こちらのコロプレス図のデータは、けっこう粗かった。日本はこんな感じ。。

でも、結局、境界線をポイントでつないで表現していることが分かる。

- 投稿日:2021-01-10T21:34:43+09:00

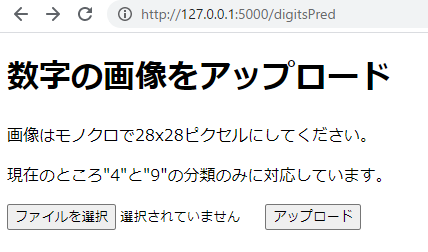

python初心者が犯罪者数を予測してみた

はじめに

まずは簡単に自己紹介させてください。

私は大学で工学(化学系)を学び、一般企業で研究員として働いて5年目になります。

今回会社から半年間の育休をもらえたので、育児の合間をぬってプログラミングを勉強することにしました。

はじめるに至った動機ですが、YouTubeで「最近は簡単にプログラミングを学べる」といった動画を多く目にし、

大学時代に少し触ったことがあったのも相まって、思い切って3か月間オンラインスクールに通うことにしました。本記事の概要

- どんな人向けの記事か

完全に初心者向けです。今からプログラミングを始めてみようという人に読んでもらいたいです。

どうやってオンラインスクールを選び、何を学んだのかということから書いています。

- この記事で挑戦したこと

3か月の受講期間で学んだ技術の中で、面白いなと思ったコードを、自分で題材を決めて動かしてみました。

具体的には、月別の犯罪者数を予測してみました。

はじめはLSTMモデルで予測してみたのですが、精度がいまいちだったため、機械学習を用いて予測してみました。オンライン学習の振り返り

- なぜAidemyを選んだのか

オンラインスクールを選ぶにあたり、たくさんの選択肢がありました。

それぞれHPを見に行ったのですが、転職成功率等のビジネスよりの広告が最も少なかったAidemyに決めました。

今回は転職のためのスキルを磨くというよりは、純粋に流行の機会学習やデフィープラーニングってどんなの?

という感情が大きかったので、結果的にこの選択は良かったです。

また、代表の方がホリエモンチャンネルに出演していたり、ヨビノリのたくみ先生が推していたのも大きかったですね。

- Aidemyで学んだこと

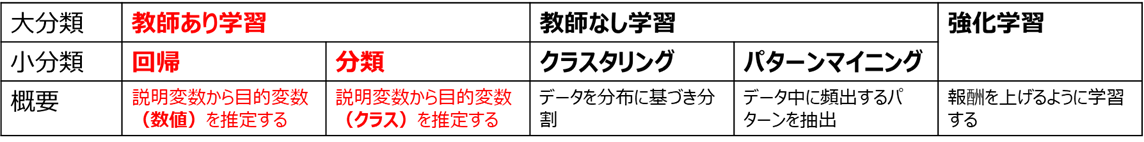

私はデータ分析コースだったのですが、

Premium Planというものを選択したので、他コースの教材も+αで学ぶことができました。

幅広く勉強できて、大変満足できるものでした。私が学習したことを簡単に書いておきますね。

(1)Numpy、Pandas、Matplotlib、データクレンジング、データハンドリング

(2)教師あり学習、教師なし学習

(3)時系列分析、株価予測、kaggleのコンペ(タイタニック号、住宅価格予測)

(4)自然言語処理、トピック抽出、感情分析

(5)深層学習画像認識

【本題】犯罪者数の予測

●犯罪者数

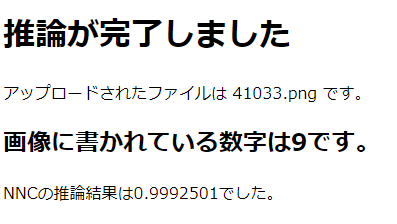

さて本題です。 今回は月別の犯罪者数を予測してみることにしました。まずは、LSTMモデルでの予測を行います。

使用するデータはe-Statという政府の統計を管理しているページから引っ張ってきました。

この中の「罪名別被疑事件の処理人員(2007年1月~2018年1月)」の数字を扱います。※「犯罪認知件数」という言葉の方が一般的かもしれませんが、

犯罪を件数単位ではなく、人数単位でカウントしたかったのでこの統計を選びました。●データの読み込みとindex,columnsの除去

使用するデータは先頭Sheetの先頭列です。

また、取り出したデータの値はLSTMでの分析に適合させるため、float型に変換して読み込みます。#データの読み込み dataframe = pd.read_excel('./blog_data/criminal_prediction.xlsx', sheet_name=0, usecols=[0]) #index,columns除去 dataset = dataframe.values #float型に変換 dataset = dataset.astype('float32')●トレーニングデータ・テストデータの作成

前半の2/3をトレーニング用、残りの1/3をテスト用に分ける操作を行います。

トレインデータが89個、テストデータが44個です。# トレーニングデータにするデータ件数を算出 train_size = int(len(dataset) * 0.67) # トレーニングデータ、テストデータに分割 train, test = dataset[0:train_size, :], dataset[train_size:len(dataset), :] print(len(dataset), len(train), len(test)) #出力結果:133 89 44●データのスケーリング

前処理でスケーリングを行います。

ここでは正規化(MinMaxScaler)を用いて、トレーニングデータを基準としたスケーリングを行いました。from sklearn.preprocessing import MinMaxScaler # 最小値が0, 最大値が1となるようにスケーリング方法を定義 scaler = MinMaxScaler(feature_range=(0, 1)) # `train`のデータを基準にスケーリングするようパラメータを定義 scaler_train = scaler.fit(train) # パラメータを用いて`train`データをスケーリング train = scaler_train.transform(train) # パラメータを用いて`test`データをスケーリング test = scaler_train.transform(test)●入力データ・正解ラベルの作成

LSTMの予測では、基準となる時点からいくつか前のデータを用いて次の時点のデータの予測を行います。

ここでは入力データと正解ラベルを次の要件で作成しました。・入力データ:基準点を含め、3か月前の時点までのデータ

・正解ラベル:基準点の次の時点のデータimport numpy as np # 入力データ・正解ラベルを作成する関数を定義 # data_X:入力データ。n月分のデータを1セットとする # data_Y:正解ラベル。Xの翌月を正解とする def create_dataset(dataset, look_back): data_X, data_Y = [], [] for i in range(look_back, len(dataset)): data_X.append(dataset[i-look_back:i, 0]) data_Y.append(dataset[i, 0]) return np.array(data_X), np.array(data_Y) # 3つ前のデータを1セットとする入力データと正解ラベルを作成 look_back = 3 # 作成した関数`create_dataset`を用いて、入力データ・正解ラベルを作成 train_X, train_Y = create_dataset(train, look_back) test_X, test_Y = create_dataset(test, look_back)●データの整形

作成したデータはLSTMで分析できるデータ形式ではないので、入力データの整形を行います。

入力データを行数×変数数×カラム数の3次元の行列に変換し、LSTMで分析できるデータ形式に整形します。・行数:データの総数

・変数数:1セットのデータに含まれる要素数 = look_back

・カラム数:扱うデータの種別数 = 1(犯罪者数の1種類だけ)# データの整形 # 3次元のnumpy.ndarrayに変換 train_X = train_X.reshape(train_X.shape[0], train_X.shape[1], 1) test_X = test_X.reshape(test_X.shape[0], test_X.shape[1], 1)●LSTMネットワークの構築と訓練

次に、LSTMネットワークを構築し、用意したデータを用いてモデルの訓練を行います。from sklearn.metrics import mean_squared_error import keras from keras.models import Sequential from keras.layers.core import Dense, Activation from keras.layers.recurrent import LSTM from keras.callbacks import EarlyStopping # LSTMモデルを作成 model = Sequential() model.add(LSTM(64, input_shape=(look_back, 1), return_sequences=True)) model.add(LSTM(32)) model.add(Dense(1)) # モデルをコンパイル model.compile(loss='mean_squared_error', optimizer='adam') # 訓練 model.fit(train_X, train_Y, epochs=50, batch_size=1, verbose=1)●データの予測・評価

モデルの構築と訓練が終了したので、データの予測と評価を行います。

出力されたデータの予測結果を正しく評価するには、スケーリングしたデータを元に戻す必要があります。

元に戻すには、transform()メソッドの逆変換を行う、inverse_transform()メソッドを用います。

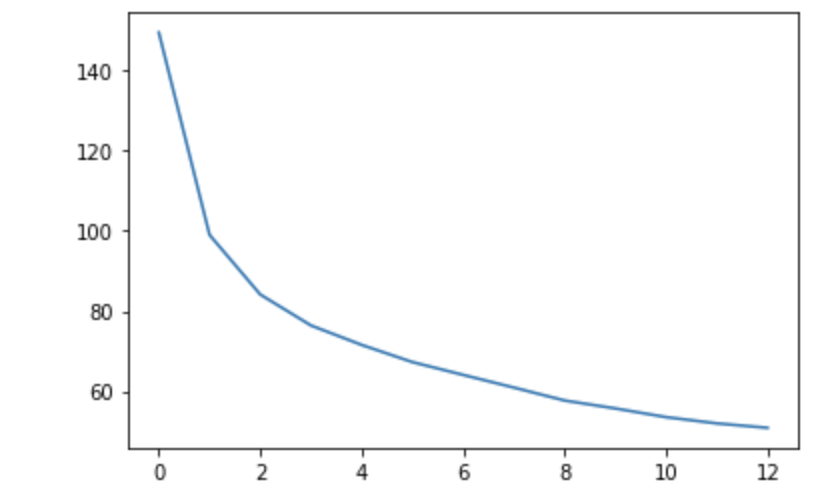

データが少ないせいか、誤差が大きくなっていますね。import math # 予測データを作成 train_predict = model.predict(train_X) test_predict = model.predict(test_X) # スケールしたデータを元に戻す train_predict = scaler_train.inverse_transform(train_predict) train_Y = scaler_train.inverse_transform([train_Y]) test_predict = scaler_train.inverse_transform(test_predict) test_Y = scaler_train.inverse_transform([test_Y]) # 予測精度の計算 train_score = math.sqrt(mean_squared_error(train_Y[0], train_predict[:, 0])) print('Train Score: %.2f RMSE' % (train_score)) #出力結果:Train Score: 13596.52 RMSE test_score = math.sqrt(mean_squared_error(test_Y[0], test_predict[:, 0])) print('Test Score: %.2f RMSE' % (test_score)) #出力結果:Test Score: 14855.30 RMSE●予測結果の可視化

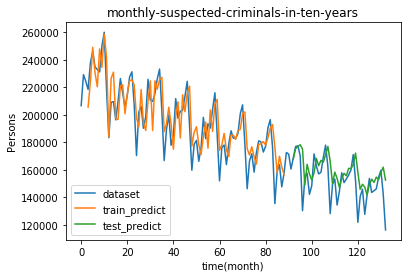

次の3つを1つのグラフにプロットします。

・読み込んだままのデータ(dataset)

・トレーニングデータから予測した値(train_predict)

・テストデータから予測した値(test_predict)import matplotlib.pyplot as plt # プロットのためのデータ整形 train_predict_plot = np.empty_like(dataset) train_predict_plot[:, :] = np.nan train_predict_plot[look_back:len(train_predict)+look_back, :] = train_predict test_predict_plot = np.empty_like(dataset) test_predict_plot[:, :] = np.nan test_predict_plot[len(train_predict)+(look_back*2):len(dataset), :] = test_predict # データのプロット plt.title("monthly-suspected-criminals-in-ten-years") plt.xlabel("time(month)") plt.ylabel("Persons") # 読み込んだままのデータをプロット plt.plot(dataset, label='dataset') # トレーニングデータから予測した値をプロット plt.plot(train_predict_plot, label='train_predict') # テストデータから予測した値をプロット plt.plot(test_predict_plot, label='test_predict') plt.legend(loc='lower left') plt.show()

X軸の0のところが2007年1月です。意外にも犯罪者数は減少していますね。

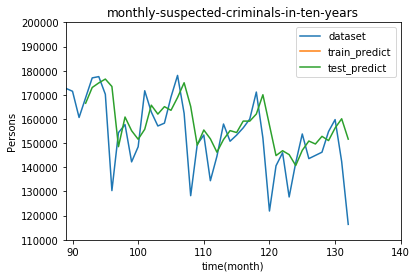

テストデータの部分を拡大してみます。import matplotlib.pyplot as plt import numpy as np # プロットのためのデータ整形 train_predict_plot = np.empty_like(dataset) train_predict_plot[:, :] = np.nan train_predict_plot[look_back:len(train_predict)+look_back, :] = train_predict test_predict_plot = np.empty_like(dataset) test_predict_plot[:, :] = np.nan test_predict_plot[len(train_predict)+(look_back*2):len(dataset), :] = test_predict # データのプロット plt.title("monthly-suspected-criminals-in-ten-years") plt.xlabel("time(month)") plt.ylabel("Persons") #範囲設定 plt.xlim(89,140) plt.ylim(110000,200000) # 読み込んだままのデータをプロット plt.plot(dataset, label='dataset') # トレーニングデータから予測した値をプロット plt.plot(train_predict_plot, label='train_predict') # テストデータから予測した値をプロット plt.plot(test_predict_plot, label='test_predict') plt.legend(loc='upper right') plt.show()うーん、やはりデータが少ないせいか、ところどころ誤差が目立ちますね。

機械学習で予測してみた

少し不完全燃焼な気分だったので、視点を変えてもう少し工夫してみました。

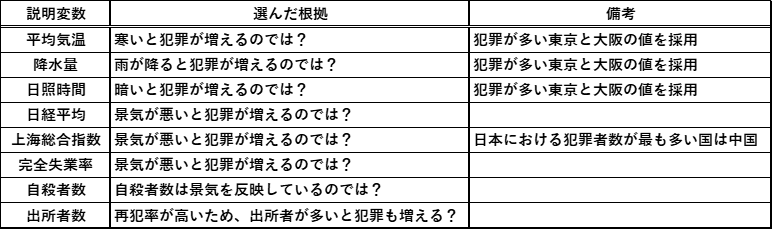

何か犯罪者数とは全く異なる説明変数で、犯罪者数を予測できないかと考え、次のようなデータを用意しました。

これらを使って以下のように重回帰分析を行いました。import pandas as pd from sklearn.model_selection import train_test_split from sklearn.linear_model import LinearRegression #データの読み込み、日付の削除 df = pd.read_excel('./blog_data/criminal_prediction.xlsx', sheet_name=0) df = df.drop(df.columns[0], axis=1) X = df.drop('被疑事件の受理人員', axis=1) y = df['被疑事件の受理人員'] #データの分割 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42) #訓練、評価 model = LinearRegression() model.fit(X_train, y_train) R2 = model.score(X_test, y_test) print("{:.5f}".format(R2)) #出力結果:0.79810まずまずの結果ですね。とりあえず満足です。

おわりに

受講期間は終わってしまいましたが、これからも時間を見つけて少しずつ勉強していこうと思います。

卒業までに実際にコードを実行しながら、幅広く触れることができて良かったです。

- 投稿日:2021-01-10T20:06:56+09:00

[pyqtgraph] SignalProxyを理解してグラフ上にカーソルを追従する十字線を作成する

やりたいこと

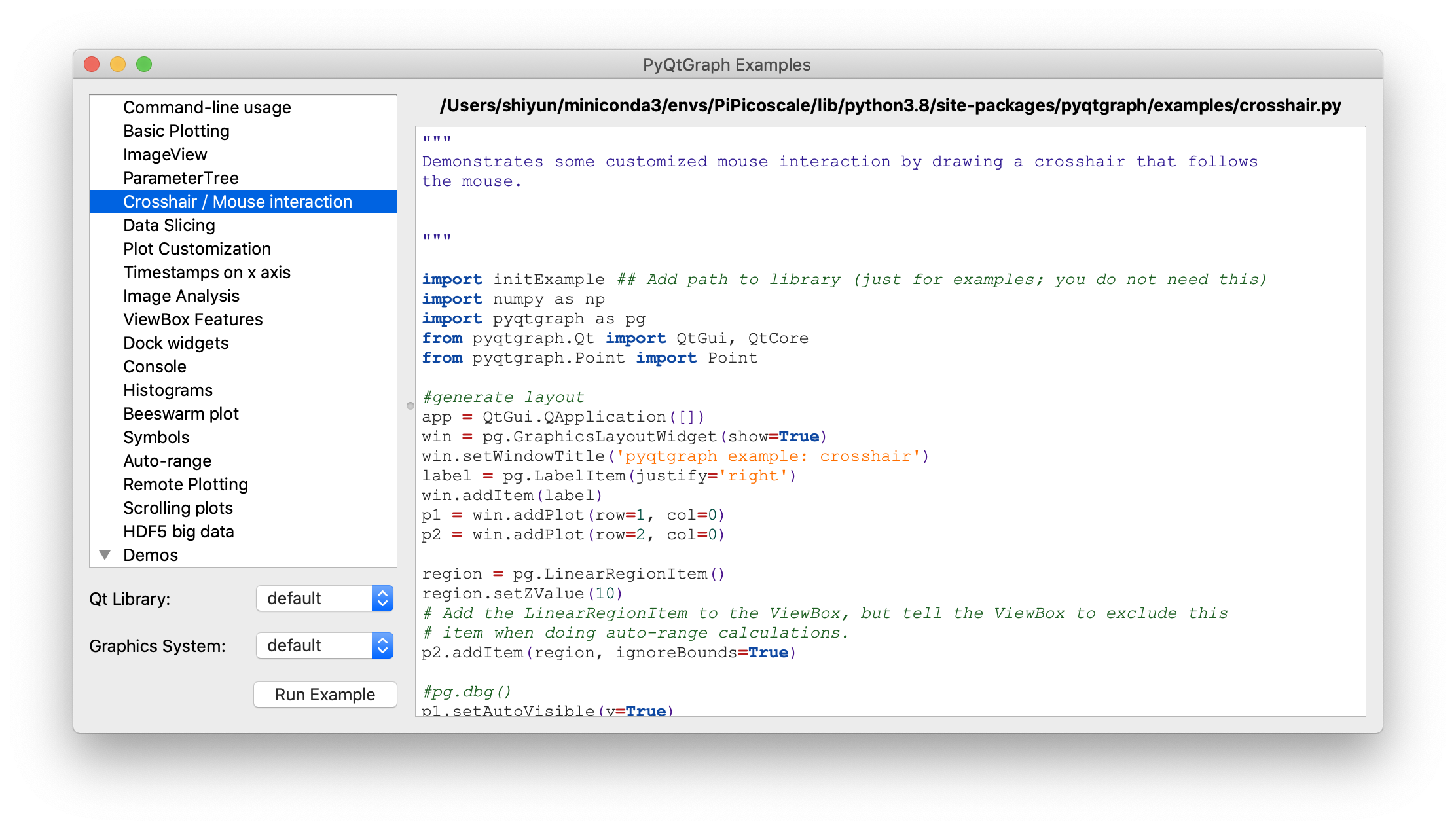

pyqtgraph.exsamples.run()のCrosshair / Mouse interactionにあるカーソルに合わせて動く十字線を作成したい。

サンプルコードの中に初めてみるスクリプトがあった。

proxy = pg.SignalProxy(p1.scene().sigMouseMoved, rateLimit=60, slot=mouseMoved)SignalProxyは何をしているのか理解しながら十字線を作成していく。

環境

Mac OS

Python 3.8.5PyQt5 5.15.2

PyQt5-sip 12.8.1

pyqtgraph 0.11.1

pip install PyQt5 PyQt5-sip pyqtgraphpyqtgraph.exsamples

import pyqtgraph.examples as ex ex.run()で色々なサンプルグラフが見れます。今回参考にしたのはCrosshair / Mouse interactionです。

SignalProxy

SignalProxyのアノテーションの内容

Object which collects rapid-fire signals and condenses them

into a single signal or a rate-limited stream of signals.

Used, for example, to prevent a SpinBox from generating multiple

signals when the mouse wheel is rolled over it.Emits sigDelayed after input signals have stopped for a certain period of

time.Initialization arguments:

signal - a bound Signal or pyqtSignal instance

delay - Time (in seconds) to wait for signals to stop before emitting (default 0.3s)

slot - Optional function to connect sigDelayed to.

rateLimit - (signals/sec) if greater than 0, this allows signals to stream out at a

steady rate while they are being received.短時間で同じシグナルが大量に発生する場合使用するオブジェクト。

発生したシグナルを全て発光するのではなく、一定間隔ごとに一つだけ発光する。引数

- signal : 処理したいシグナルを指定

- delay : シグナルを受信してから発光するまでの待ち時間。デフォルトは0.3秒。指定する時は秒単位で入力。

- slot : シグナルが発光した時に実行されるスロット

- rateLimit : シグナルが発光する間隔を正確に設定したい時に使う。単位は[Hz]。デフォルトは0。

どうやって間隔を指定している?

SignalProxyのコンストラクタとシグナルを受信している部分

self.timerがtimeoutした時スロットが実行される。sigDelayed = QtCore.Signal(object) def __init__(self, signal, delay=0.3, rateLimit=0, slot=None): """Initialization arguments: signal - a bound Signal or pyqtSignal instance delay - Time (in seconds) to wait for signals to stop before emitting (default 0.3s) slot - Optional function to connect sigDelayed to. rateLimit - (signals/sec) if greater than 0, this allows signals to stream out at a steady rate while they are being received. """ QtCore.QObject.__init__(self) self.delay = delay self.rateLimit = rateLimit self.args = None self.timer = ThreadsafeTimer.ThreadsafeTimer() self.timer.timeout.connect(self.flush) self.lastFlushTime = None self.signal = signal self.signal.connect(self.signalReceived) if slot is not None: self.blockSignal = False self.sigDelayed.connect(slot) self.slot = weakref.ref(slot) else: self.blockSignal = True self.slot = None def signalReceived(self, *args): """Received signal. Cancel previous timer and store args to be forwarded later.""" if self.blockSignal: return self.args = args if self.rateLimit == 0: self.timer.stop() self.timer.start(int(self.delay * 1000) + 1) else: now = time() if self.lastFlushTime is None: leakTime = 0 else: lastFlush = self.lastFlushTime leakTime = max(0, (lastFlush + (1.0 / self.rateLimit)) - now) self.timer.stop() self.timer.start(int(min(leakTime, self.delay) * 1000) + 1)rateLimitを指定していない時

rateLimitのデフォルトは0

if self.rateLimit == 0: self.timer.stop() self.timer.start(int(self.delay * 1000) + 1)シグナルが最後に受信されてから

self.delay秒後に発光するようにタイマーを再設定している。

timer.start()はミリ秒で指定する為 *1000している。rateLimitを指定している時

else: now = time() if self.lastFlushTime is None: leakTime = 0 else: lastFlush = self.lastFlushTime leakTime = max(0, (lastFlush + (1.0 / self.rateLimit)) - now) self.timer.stop() self.timer.start(int(min(leakTime, self.delay) * 1000) + 1)

self.lastFlushTimeはシグナルが最後に発行した時のunix時刻。シグナルが最後に発光してから十分に時間が経過している時

例

-self.rateLimit= 5

-self.lastFlushTime= 100

-now= 102

leakTime = max(0, (lastFlush + (1.0 / self.rateLimit)) - now)

= max(0, -1.8) でleakTime= 0

その後のself.timer.start(int(min(leakTime, self.delay) * 1000) + 1)でself.delayの方が大きい為delay秒後に発光する。シグナルが(1 / rateLimit)秒未満に発生した時

例

-self.rateLimit= 5

-self.lastFlushTime= 100

-now= 100.01

leakTime = max(0, (lastFlush + (1.0 / self.rateLimit)) - now)

= max(0, 0.19) でleakTime= 0.19その後の

self.timer.start(int(min(leakTime, self.delay) * 1000) + 1)でself.delayより大きければleaktime秒後に発光する。最後に発行してからnowまでは0.01秒経過している為、0.01 + 0,19 = 0.2 = 5[Hz]

要するに

最初のこれは

proxy = pg.SignalProxy(p1.scene().sigMouseMoved, rateLimit=60, slot=mouseMoved)マウスが動いたら(

p1.scene().sigMouseMoved)を60 HzごとにmouseMovedを実行してという意味。コード

SignalProxyが何をしているか分かったので使ってみる。

プロット用にnumpyを使用。pip install numpy"""グラフにマウスカーソルを追いかける十字線を追加する""" import dataclasses from typing import Optional import sys import numpy as np from PyQt5 import QtWidgets, QtCore import pyqtgraph as pg SAMPLE_DATA = np.random.rand(500) * 10 @dataclasses.dataclass class AddLineWidget(pg.GraphicsLayoutWidget): """メイン画面 Attributes # ---------- parent: Optional[QtWidgets.QWidget] default=None 親画面 plotter: pyqtgraph.graphicsItems.PlotItem.PlotItem.PlotItem メイングラフ view_box: pyqtgraph.graphicsItems.ViewBox.ViewBox.ViewBox メイングラフのViewBox vertical_line: pyqtgraph.graphicsItems.InfiniteLine.InfiniteLine マウスカーソルを追いかける縦線 horizontal_line: pyqtgraph.graphicsItems.InfiniteLine.InfiniteLine マウスカーソルを追いかける横線 proxy: pyqtgraph.SignalProxy.SignalProxy マウスカーソルが動いた時に発生するシグナルの発光を制御する """ parent: Optional[QtWidgets.QWidget] = None def __post_init__(self) -> None: """スーパークラス読み込みとplot, line追加""" super(AddLineWidget, self).__init__(parent=self.parent) self.add_plot_and_viewbox() self.add_line() self.set_proxy() def add_plot_and_viewbox(self) -> None: """plotとviewboxを追加する""" self.plotter = self.addPlot(row=0, col=0) self.plotter.showGrid(x=True, y=True, alpha=0.8) self.plotter.plot(SAMPLE_DATA, pen=pg.mkPen('#f00')) # self.plotterのViewBox self.view_box = self.plotter.vb def add_line(self): """カーソルに合わせて動くラインの追加""" # デフォルトでは見えにくいので色、幅指定 self.vertical_line = pg.InfiniteLine(angle=90, movable=False, pen=pg.mkPen('#fff', width=5)) self.horizontal_line = pg.InfiniteLine(angle=0, movable=False, pen=pg.mkPen('#fff', width=5)) self.plotter.addItem(self.vertical_line, ignoreBounds=True) self.plotter.addItem(self.horizontal_line, ignoreBounds=True) def set_proxy(self) -> None: """SignalProxyを設定""" self.proxy = pg.SignalProxy(self.plotter.scene().sigMouseMoved, rateLimit=60, slot=self.mouse_moved) @QtCore.pyqtSlot(tuple) def mouse_moved(self, evt) -> None: """マウスが動いた時に60FPSごとに実行される関数 PlotItem.scene().sigMouseMovedはグラフの座標ではなく画面のピクセル単位の座標を返す Parameters ---------- evt: tuple 画面のピクセル単位の座標 ex) (PyQt5.QtCore.QPointF(2.0, 44.0),) """ # 画面のピクセル座標取得 # ex) pos=PyQt5.QtCore.QPointF(2.0, 44.0) pos = evt[0] # posがグラフ内の座標だったら if self.plotter.sceneBoundingRect().contains(pos): # グラフの座標取得 # ex) mousePoint=PyQt5.QtCore.QPointF(141.6549821809388, 4.725564511858496) mouse_point = self.view_box.mapSceneToView(pos) # 線をmouse_pointの座標に移動 # ex) mouse_point.x()=46.13389087421787 self.vertical_line.setPos(mouse_point.x()) # ex) mouse_point.y()=9.535145662930628 self.horizontal_line.setPos(mouse_point.y()) def main() -> None: app = QtWidgets.QApplication(sys.argv) window = AddLineWidget(parent=None) window.show() sys.exit(app.exec_()) if __name__ == "__main__": main()右上に座標を表示する

"""グラフにマウスカーソルを追いかける十字線を追加する""" import dataclasses from typing import Optional import sys import numpy as np from PyQt5 import QtWidgets, QtCore import pyqtgraph as pg SAMPLE_DATA = np.random.rand(500) * 10 @dataclasses.dataclass class AddLineWidget(pg.GraphicsLayoutWidget): """メイン画面 Attributes # ---------- parent: Optional[QtWidgets.QWidget] default=None 親画面 plotter: pyqtgraph.graphicsItems.PlotItem.PlotItem.PlotItem メイングラフ view_box: pyqtgraph.graphicsItems.ViewBox.ViewBox.ViewBox メイングラフのViewBox vertical_line: pyqtgraph.graphicsItems.InfiniteLine.InfiniteLine マウスカーソルを追いかける縦線 horizontal_line: pyqtgraph.graphicsItems.InfiniteLine.InfiniteLine マウスカーソルを追いかける横線 proxy: pyqtgraph.SignalProxy.SignalProxy マウスカーソルが動いた時に発生するシグナルの発光を制御する """ parent: Optional[QtWidgets.QWidget] = None def __post_init__(self) -> None: """スーパークラス読み込みとlabel, plot, line追加""" super(AddLineWidget, self).__init__(parent=self.parent) self.add_label() self.add_plot_and_viewbox() self.add_line() self.set_proxy() def add_plot_and_viewbox(self) -> None: """plotとviewboxを追加する""" self.plotter = self.addPlot(row=0, col=0) self.plotter.showGrid(x=True, y=True, alpha=0.8) self.plotter.plot(SAMPLE_DATA, pen=pg.mkPen('#f00')) # self.plotterのViewBox self.view_box = self.plotter.vb def add_label(self) -> None: """座標を表示するラベルを追加""" self.label = pg.LabelItem(justify='right') self.addItem(self.label) def add_line(self): """カーソルに合わせて動くラインの追加""" # デフォルトでは見えにくいので色、幅指定 self.vertical_line = pg.InfiniteLine(angle=90, movable=False, pen=pg.mkPen('#fff', width=5)) self.horizontal_line = pg.InfiniteLine(angle=0, movable=False, pen=pg.mkPen('#fff', width=5)) self.plotter.addItem(self.vertical_line, ignoreBounds=True) self.plotter.addItem(self.horizontal_line, ignoreBounds=True) def set_proxy(self) -> None: """SignalProxyを設定""" self.proxy = pg.SignalProxy(self.plotter.scene().sigMouseMoved, rateLimit=60, slot=self.mouse_moved) @QtCore.pyqtSlot(tuple) def mouse_moved(self, evt) -> None: """マウスが動いた時に60FPSごとに実行される関数 PlotItem.scene().sigMouseMovedはグラフの座標ではなく画面のピクセル単位の座標を返す Parameters ---------- evt: tuple 画面のピクセル単位の座標 ex) (PyQt5.QtCore.QPointF(2.0, 44.0),) """ # 画面のピクセル座標取得 # ex) pos=PyQt5.QtCore.QPointF(2.0, 44.0) pos = evt[0] # posがグラフ内の座標だったら if self.plotter.sceneBoundingRect().contains(pos): # グラフの座標取得 # ex) mousePoint=PyQt5.QtCore.QPointF(141.6549821809388, 4.725564511858496) mouse_point = self.view_box.mapSceneToView(pos) # SAMPLE_DATA内の座標であればx, y値を表示する index = int(mouse_point.x()) if 0 < index < len(SAMPLE_DATA): self.label.setText( f"<span style='font-size: 18pt'>x={mouse_point.x():.3f}," f"<span style='color: red'>y1={SAMPLE_DATA[index]:.3f}</span>") # 線をmouse_pointの座標に移動 # ex) mouse_point.x()=46.13389087421787 self.vertical_line.setPos(mouse_point.x()) # ex) mouse_point.y()=9.535145662930628 self.horizontal_line.setPos(mouse_point.y()) def main() -> None: app = QtWidgets.QApplication(sys.argv) window = AddLineWidget(parent=None) window.show() sys.exit(app.exec_()) if __name__ == "__main__": main()参考

SignalProxy

Python pyqtgraph package v0.10.0, pyqtgraph.SignalProxy module source code :: PyDoc.netViewBox

ViewBox — pyqtgraph 0.11.1.dev0 documentationSignalProxy

Python pyqtgraph package v0.10.0, pyqtgraph.SignalProxy module source code :: PyDoc.net

- 投稿日:2021-01-10T20:04:14+09:00

Google Colaboratoryの90分セッション切れ対策 --- Pythonをつかう!---

やること

Google Colab はプログラム実行中でも、何もさわらないと90分経過でプログラムが止まってしまいます。

このセッション切れ対策として、Google Chromeのアドオンを使う方法やスクリプトを実行する方法が紹介されていましたが、アドオンがうまくいかなかったので、Pythonプログラムで画面を定期的にクリックするという原始的な方法のシンプルプログラムを書きましたので、その紹介です。やりかた

1. pyautoguiモジュールをインストールする

画面をクリックするのにpyautoguiモジュールを使用します。pipを使って普通にインストールします。

pip install pyautogui

2. Google Colaboratoryを動かす

いつもどおりにColabでプログラムをはしらせます。ブラウザはなんでもOKです。

3. Pythonプログラムを動かす

ターミナルかエディタから、以下のプログラムを動かします。一応、for_colab.pyと名付けてますが、自由に名前をつけて保存、実行してください。

for_colab.py#! python3 # -*- coding: utf-8 -*- # colabを継続して使う import time import pyautogui print() print('''10分ごとにマウスカーソルを左右に少し動かし、クリックします。 12時間後に終了します。途中で停止するときは、Ctrl + c を押してください。 ''') try: dir = -10 counter = 0 while counter < 72: time.sleep(600) pyautogui.moveRel(dir, 0) dir = - dir pyautogui.click() counter += 1 # print('カウンター:', counter) # クリックしたときに出力したい場合はコメントアウト print('停止:12時間経過') except KeyboardInterrupt: print('停止:Ctrl + c による終了')

プログラムはとてもシンプルで、time sleepで10分待ったあと、ポインタを右(または左)に少し動かしクリックします。

それを72回(=12時間)実施したら終了します。4. google colabに戻る

先ほどプログラムをはしらせたcolabに戻って、プログラムが動いているのを確認します。

colabのプログラムの最後の方に空欄のセルをいくつか作っておき、その場所にポインタをおいておきます。以上です。

注意事項

- 「for_colab.py」は定期的にクリックしますので、ポインターをどこに置いておくかが重要です。左右の動きを繰り返すので、全然違う方に動いていくことはありませんが、colabの方がスクロールしていて思いもかけないところをクリックしないように、最後にポインターを置く位置に気をつけてください。

- colabとは別のプログラムですので、colabの計算が終わっても当然「for_colab.py」は止まりません。colabの計算が終了したら、ctrl-Cで「for_colab.py」を停止させてください。私は止め忘れていて、なんかパソコンの動きが変になった、と思ったらバックで「for_colab.py」が動いてました...

- 10分間隔でクリックしますが、その前にパソコンがスリープしないように、スリープまでの時間は10分超に設定してください。

- 単純に時間がきたらクリックするだけの機能ですので、動作中は別の作業はできません。睡眠学習用として使用ください。

プログラム「for_colab.py」は10分間隔でクリックするようにしていますが、colabのルール的には90分以内にクリックすればよいので、time sleepの値を各自の好みで変更してください。

また、クリック時にクリックしたことを確認したければ、コメントアウトしているPRINT文を有効にしてください。

単純なプログラムですので、使いやすいように変更して使ってみてください。Google Colaboratoryは無料でGPUが使用できるので、機械学習の訓練にとても便利ですよね。

寝ている間にGoogle先生に訓練してもらいましょう。'--------------------おしまい--------------------'

- 投稿日:2021-01-10T19:50:23+09:00

指定したURLのリンクが有効かどうかをチェックするpythonスクリプトを作成2

以下の更新版

コード

こちらにあるものと同じ

チェック対象のURLリスト作成

カレントディレクトリ以下の

https://...と続く文字列をなるべくgrepする。input.txtという名前で保存。grep -r "https://" * > test.txt cat test.txt | sed -e 's/.*https//' | sed "s/^/http/g" > test.txt cat test2.txt | sed 's/>//g' | sed 's/"//g' | sed 's/)//g' | sed 's/;//g' | sed 's/]//g' | cut -d' ' -f 1 > input.txtチェック

input.txtのURLにアクセスできるかどうかを確認する。$ python3 check_url.py # 出力結果 # アクセスできる→OK # アクセスできない→NotFound # ※ ただし、grep結果が意図通りでない場合もあるので確認する。 NotFound:http://www.kernel.org/pub/linux/kernel/v5.x/linux-${PV}.tar.xz OK:http://facebook.github.io/watchman/ ...check_url.py#-*- using:utf-8 -*- import urllib.request, urllib.error with open('out.txt', 'w') as txt: txt.write("chdck result\n") def checkURL(url): try: f = urllib.request.urlopen(url) f.close() return True except: return False if __name__ == '__main__': with open("./input.txt") as f: for url in f: # print(url, end='') ret = checkURL(url) if ret == True: result = "OK:" else: result = "NotFound:" ret_text = result + url #ret_text = ret_text.replace('\n', '') print(ret_text) if ret != True: with open('out.txt', 'a') as txt: txt.write(ret_text)結果

結果OK/NGを以下に出力する

cat out.txt参考

指定したURLのリンクが有効かどうかをチェックするpythonスクリプトを作成

入力した文字列から、指定した文字列より右の文字列をとりだす

- 投稿日:2021-01-10T19:32:05+09:00

AGL(Automotive Grade Linux)の公開ブランチに、ソースコードをcommitするまで2

目的

AGL(Automotive Grade Linux)の公開ブランチに、ソースコードをcommitするまでの備忘録です。

AGLについてはこちらやAutomotive Linux Wikiをご参照本記事は以下の更新版です

準備

AGLの公開コードに対しては、誰でも更新リクエストを送ることが可能になっています。

Contributing to the AGL Distro

The AGL community appreciates feedback, ideas, suggestion, bugs and documentation just as much as code.リクエストしたコードは

gerritを通じてtrackおよびreviewが行われます。Contributing Code

We use Gerrit to track and review changes to AGL software (i.e. projects at gerrit.automotivelinux.org).以下の開発向けドキュメントに詳細が記載されているのでご参考ください。

Welcome to the Automotive Grade Linux (AGL) documentation.

5_How_To_Contributeソースコード取得

以下を参考にソースコード取得します。

1.Define Your Top-Level Directoryexport AGL_TOP=$HOME/AGL echo 'export AGL_TOP=$HOME/AGL' >> $HOME/.bashrc mkdir -p $AGL_TOP

2.Download the repo Tool and Set Permissionsmkdir -p $HOME/bin export PATH=$HOME/bin:$PATH echo 'export PATH=$HOME/bin:$PATH' >> $HOME/.bashrc curl https://storage.googleapis.com/git-repo-downloads/repo > $HOME/bin/repo chmod a+x $HOME/bin/repo以下は

stableブランチではなく、masterブランチを取得する場合

3.Cutting-Edge Files: Using the "cutting-edge" AGL files gives you a snapshot of the "master" branch.cd $AGL_TOP mkdir master cd master repo init -u https://gerrit.automotivelinux.org/gerrit/AGL/AGL-repo repo synccommit用コード作成

元記事同様に、以下のような観点でcommit用コードを作成してみます。

commit用コード作成

いきなりの機能追加は大変なので、期限切れリンクの修正や、ビルドワーニング修正で何か貢献できないか、という観点で確認します。commitのための前準備

元記事記を参考に、前準備をします

AGLのコードリリースの際、

CIATという継続的インテグレーションの評価システムにcommitすることになります。

CIATについては以下が詳しいです。

Building and testing an automotive platform

How to Write Tests for the AGL HW Test Infra

20161210_第8回jenkins勉強会Gerrit Serverは以下URLからアクセスすることが可能です。

gerrit.automotivelinux.org

Building AGL with the Yocto Project - A Crashcourse -Gerritはレビューシステムであり、commitは最終的にExpert Memberの承認を受けてMergeされます。

また、自動評価も実行されます。Gerrit上は以下の通り記載されています。CR : Code review V : Verified CIB : ci-image-build CIBT : ci-image-boot-testcommit手順

アカウント作成

以下を参考にLinuxFoundationのアカウント作成します。

Creating Linux Foundation ID

Go to the Linux Foundation ID website.上記Documentの通り作成し、Gerritにsign inできればOK

Access Gerrit by selecting Sign In, and use your new Linux Foundation account ID to sign in.

gerritのconfiguring

次に、gerritとssh通信できるようにします。commitのために必要です。

SSH key生成

こちらを参考に、

ssh-keygenします。

生成したprivate key,public keyのうち、public keyをgerrit側に登録します。public keyをgerritに登録

元記事同様に、こちらを参考に、gerritに生成した

public keyを登録します。(private keyではない)Finally, add the public key of the generated key pair to the Gerrit server, with the following steps:

1.Go to Gerrit.

2.Click on your account name in the upper right corner.

3.From the pop-up menu, select Settings.

4.On the left side menu, click on SSH Public Keys.

5.Paste the contents of your public key ~/.ssh/id_rsa.pub and click Add key.gerritとssh通信する際に正しい鍵ペアが使われるように、

~/.ssh/configに以下のように記載しておく。you need to create a ~/.ssh/config file modeled after the one below.

host gerrit.automotivelinux.org

HostName gerrit.automotivelinux.org

IdentityFile ~/.ssh/id_rsa_automotivelinux_gerrit

User

is your Linux Foundation ID and the value of IdentityFile is the name of the public key file you generated.いざ、commit

上記が完了し、修正ファイルも準備できたら、以下記事を参考にcommitを進めます。

コマンドは以下を参考

修正対象のリポジトリに移動し、remote branchが意図通りか確認する

(以下はmeta-aglにcommitする場合の例)cd meta-agl git remote -v agl https://gerrit.automotivelinux.org/gerrit/AGL/meta-agl (fetch) agl ssh://gerrit.automotivelinux.org:29418/AGL/meta-agl (push)修正対象ファイルを

git add,git commit --signoffする。git add (修正対象ファイル) git commit --signoff > Please sign you commit before you submit the change (otherwise it will not be accepted by gerrit): git commit --signoffremoteのレビューリクエスト用ブランチにpushする。

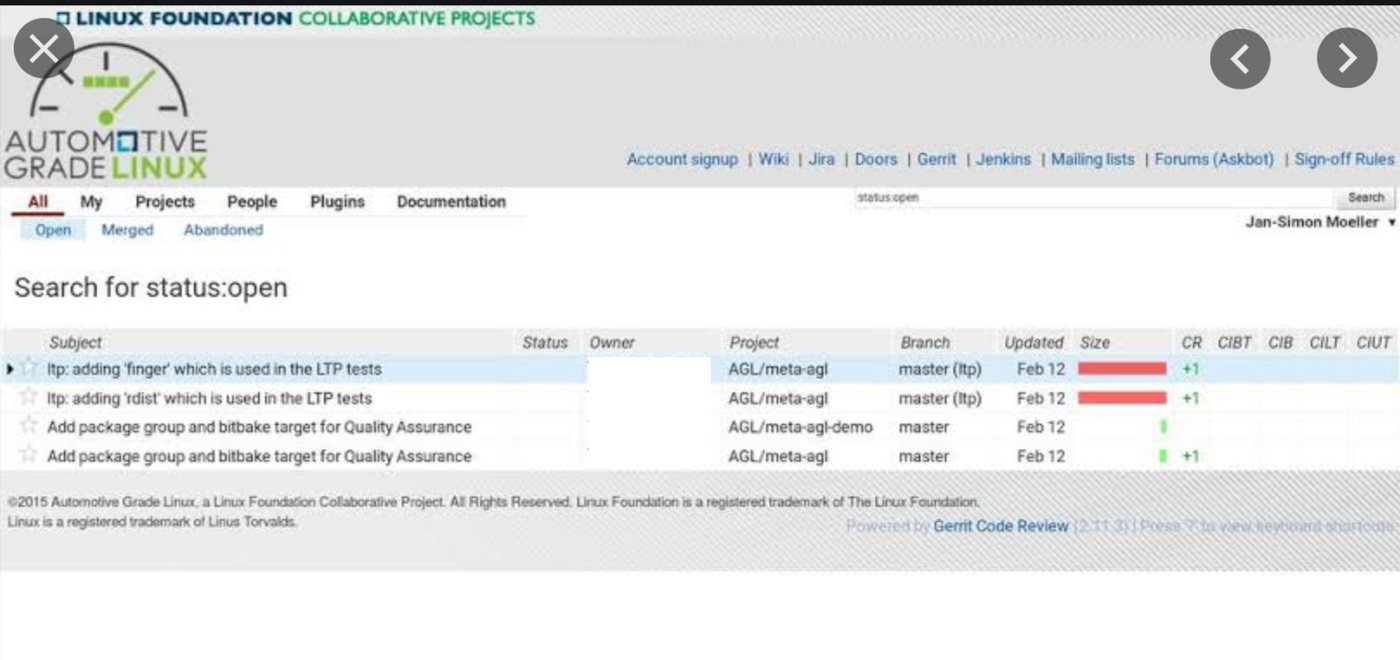

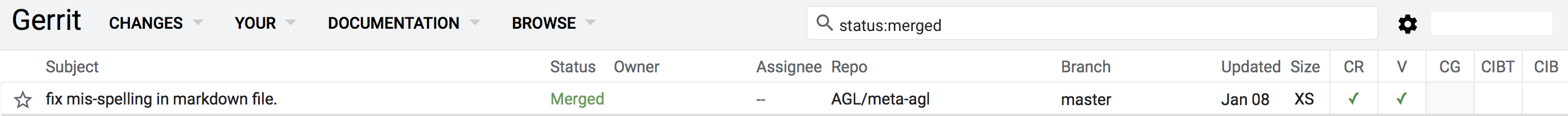

以下はmasterブランチにpushする場合。git push agl HEAD:refs/for/master # git push <remote> HEAD:refs/for/<targetbranch>以下記事のように、commitした内容がgerrit上から確認できればOK

Commit message記載の注意点

Commit messageはしっかり書く必要があります。(更新内容,JIRA番号,を記述する必要がある)

相手にどんな変更点かを伝える手段であるCommit メッセージを分かりやすく書く事は重要です。

特に、リモートで直接対話したことがない相手に対して意図を伝えるために尚更重要となります。

How to Write a Git Commit Message例えばbugを見つけた場合は、JIRAに類似bugがないかチェックの上、新規JIRAを発行して番号をcommit messageに書く必要がある。

Reporting bugs

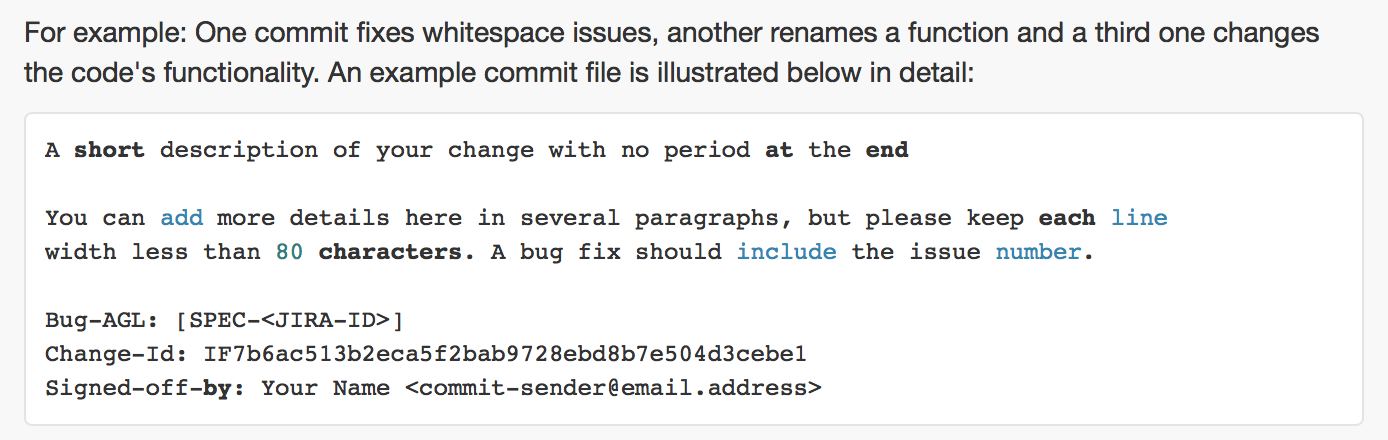

If you are a user and you have found a bug, please submit an issue using JIRA. Before you create a new JIRA issue, please try to search the existing items to be sure no one else has previously reported it.commit messageのフォーマットは以下の記述を参考

4_Submitting_Changes

For example: One commit fixes whitespace issues, another renames a function and a third one changes the code's functionality. An example commit file is illustrated below in detail:無事にmerge頂けました

簡単なtypo修正をcommitさせて頂いたところ、

無事にレビューを終え、Merged Statusになりました。感想

何か至らぬ点がありましたら、アドバイス頂けると幸いです。

参考

Automotive Linux Wiki

Contributing to the AGL Distro

Welcome to the Automotive Grade Linux (AGL) documentation.

- 投稿日:2021-01-10T19:17:56+09:00

機械学習環境構築 macbook 2021

この記事は

macbook にML用の環境作る際の備忘録

随時更新されます

環境構築手順

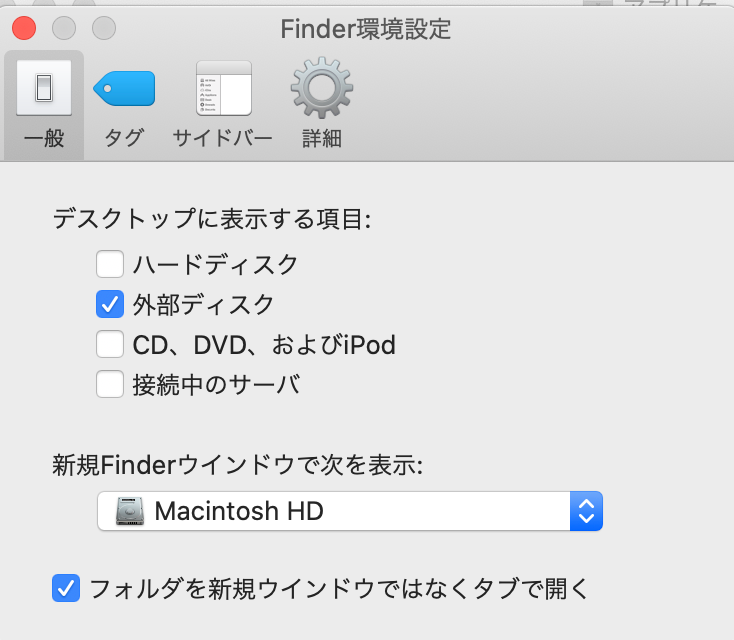

Finder

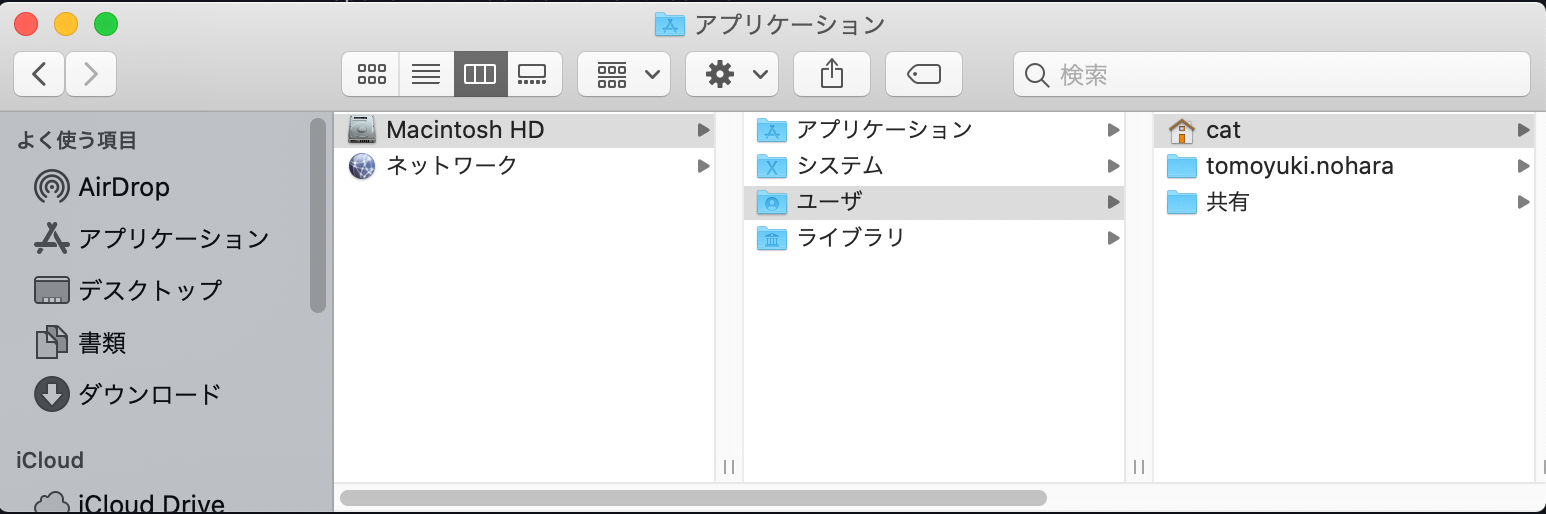

新規Finderウィンドウで次を表示:の表示項目をドライブに変更しておく.Notionのインストールについて。マルチユーザの場合は、ユーザディレクトリ配下の

Applicationディレクトリに配置する権限設定

基本的にマルチユーザで使うので権限与えておく.

(これを忘れてよくトラブル)

$ sudo chown -R $(whoami):admin /usr/local/* $ sudo chmod -R g+w /usr/local/*Mac を買ったら必ずやっておきたい初期設定 - Qiita

zshを使う

これからのデフォルトはzshになった。

もしまだbashの場合はzshにしておく。chsh -s /bin/zsh echo $SHELL cat /etc/shellszsh-autosuggestions/INSTALL.md at master · zsh-users/zsh-autosuggestions

git clone https://github.com/zsh-users/zsh-autosuggestions ~/.zsh/zsh-autosuggestions # .zshrcに追加 source ~/.zsh/zsh-autosuggestions/zsh-autosuggestions.zshターミナル環境

補完に

fishと、テーマにstarshipを使います

ただしデフォルトシェルには設定しません.# terminal brew install fish brew install startship echo 'starship init fish | source' >> ~/.config/fish/config.fish echo 'alias c="clear"' >> ~/.config/fish/config.fishその他

# いけてるcat brew install batPython

# 以下fish環境です fish # shellはzsh echo $SHELL # /bin/zsh # pyenv brew install pyenv # pyenvの初期設定をfish設定ファイルに追加 echo -e 'if command -v pyenv 1>/dev/null 2>&1; then\n eval "$(pyenv init -)"\nfi' >> ~/.zshrc # fishをリロード exec fish pyenv install 3.7.9 pyenv global 3.7.9 pyenv rehash pyenv version which python3 python3 -V which pip3 # pipenv pip3 install --upgrade pip pip3 install pipenv pipenv install pandas numpy sklearn tqdm seaborn matplotlib japanize-matplotlib pipenv install --dev autopep8 yapf isort pipenv install --dev jupyter pipenv install --dev jupyter_contrib_nbextensions pipenv install --dev autopep8 yapf isort pipenv run jupyter contrib nbextension install --user pipenv run jupyter nbextension enable code_prettify/autopep8 pipenv run jupyter nbextension enable codefolding/main pipenv run jupyter nbextension enable hide_input_all/main pipenv run jupyter nbextension enable highlight_selected_word/main pipenv run jupyter nbextension enable code_prettify/isort pipenv run jupyter nbextension enable scratchpad/main pipenv run jupyter nbextension enable table_beautifier/main pipenv run jupyter nbextension enable zenmode/main pipenv run jupyter notebook --generate-config -y echo 'c.NotebookApp.password="sha1:ef7a7482cc53:6ad03768dd7e9ca09cf0e98c1c7238ee923f5917"' > ~/.jupyter/jupyter_notebook_config.pyshellについて

fishをデフォルトシェルにすると色々と面倒がありそう.

デフォルトはzshにしておいて、都度fishを呼び出す方法でやってみる。zsh

zshの設定ファイルの読み込み順序と使い方Tipsまとめ - Qiita

zshenv > zprofile > zshrc > zloginの順で読まれる

.zshenv

順序からもわかるようにどんな場合でも必ず最初に読み込まれる。

.zprofile

ログインシェルの場合に1度だけ読み込まれる。

.zshrc

ログインシェルとインタラクティブシェルの場合だけ読み込まれる。とりあえず. zshrcに書いておけば良さそうか.

- 投稿日:2021-01-10T19:11:44+09:00

面倒なので自動化するよ!~画像自動読み込み失敗編~

こんにちは!

今回、年始の目標立案のために価値観リストを活用したいが、質問項目が画像のばかりみつかり打ち込むのが吐くほど面倒...

なので、文字の抽出を自動で行たいとおもいます。実行環境

mac

python3

環境anaconda画像を読み込む方法

・PIL(pillow)

・OpenCV

・scikit-image一番使われるのがPLIらしい。

pillowはpythonで代表的な画像処理ライブラリで、画像のリサイズや描画を容易に行うことができます。form PIL import Image,ImageFilter im = Image.open('画像ファイル名')テキストに変換する方法

・画像をテキストに変換する技術をOCR(Optical Character Recoding)という。

・OCRはOCRエンジンというソフトを使い、画像データからテキストを抽出する。

・今回はオープンソースのTesseract OCRを使用・また、PythonからOCRエンジンを使えるようにする代表的なライブラリがPyOCRです。

txt = tool.iamge_to_string( Image.open('画像ファイル名') lang=言語名, builder=pyocr.builders.TextBuilder() )実際にpng画像をテキストに変換してみる

brew install tesseractpyocrの日本語学習モデル取得のためにwgetもインストール

brew install wgetjpn.traineddataを取得

wget https://github.com/tesseract-ocr/tessdata/raw/4.00/jpn.traineddata mv jpn.traineddata /usr/local/Cellar/tesseract/4.1.1/share/tessdata※Pathが存在しない場合、以下コマンドでtesseractのpathとバージョン確認

which tessaract tessaract -v・コード実行

from PIL import Image import sys import pyocr import pyocr.builders tools = pyocr.get_available_tools() if len(tools) == 0: print("No OCR tool found") sys.exit(1) # The tools are returned in the recommended order of usage tool = tools[0] print("Will use tool '%s'" % (tool.get_name())) # Ex: Will use tool 'libtesseract' langs = tool.get_available_languages() print("Available languages: %s" % ", ".join(langs)) lang = 'jpn' print("Will use lang '%s'" % (lang)) # Ex: Will use lang 'fra' # Note that languages are NOT sorted in any way. Please refer # to the system locale settings for the default language # to use. txt = tool.image_to_string( Image.open('target.png'), lang=lang, builder=pyocr.builders.TextBuilder() ) # txt is a Python string print(txt)変換結果

python3 Image-To-Text.py Will use tool 'Tesseract (sh)' Available languages: eng, jpn, osd, snum Will use lang 'jpn' あ ⑤ り の ま ま の ⑧② を る け れ て も ぅ う ⑧② の ⑧ 見 や ① ま ょ し く な ぇ る な に が 恒 美 な こ と そ ま a す る I し く て ワ ク ワ ク ⑨ る M を す る ⑯BAMN カ を ほ っ H ま に ガ し て き せ る 街 っ て fW す る ま セ に し Au で ⑧② で Aea ⑧ の ま わ り の 美 し D も の を 味 ち う HR&⑦⑥④ と ぅ そ a る iams aaliitcdiits ‥ た ロ ラ ェ テ ィ ま か ④ 入 $ を ま る EROEREfaiR ezRtd ⑤ @ れ な い B ま や igu を ほ o 医 ま そ i し て Ma ①⑧f の ① に ⑤ っ こ と を す る 医 ま と ③ カ し て M② を す る GEiESimEreiirimeikid IR し く て W な ァ イ テ ァ を ま ど 匣 が ⑤ っ て 種 れ aREe ⑧② の 製 阿 と 口 せ る 木 た す IIN の 現 M と 00 し ④ か ぅ ょ aa ス リ ル と BA に 迦 ぅ た ん キ を き ゃ ー に ド ク ッ そ っ 0 ず i き k 牡 き る な っ て な な を 品 h る ERte itha taiii Reaeimtiisaci R た ④ 琴 0 も mmWk な じ て N 入 そ f し な か ら ま き る IR⑧ て Mi+S ぇ る ぁ そ る 国 ん で ま し と こ と ⑧②0⑨ を ①A に ぁ た ぇ る ⑧② が ょ し い と ⑧ ぅ と ち り に B あ ず る ⑧② を 合 え た な な の 思 ⑧ そ き ぇ る R と R ま る M す や が で IM ょ く ま き る HA の ① に z っ こ と ② ソ を っ か ず E に ま き る ポ ッ テ ィ フ で ま W に よ き る ① 林 で R ス め に $ き る ム 生 M が の ユ ー ェ ュ ス な m を 見 る H&lcmtg し A い て で $ き る ⑧②0 せ 荷 に ー ま り 0 りきびしいですね...

画像の画質もあるのでしょうか、それともライブラリの問題でしょうか、どちらにせよ読めません...(追記)Cloud Vision APIの方が断然精度がよいです...

GoogleのAPI、さすが精度がよいですね。

時間を見つけて実装し直していきたいです。参考

https://aitanu.com/kachikan-list/

https://qiita.com/seigot/items/7d424000c8d35e5146e4

https://punhundon-lifeshift.com/tesseract_ocr

https://webkaru.net/dev/mac-wget-command-install/

https://cloud.google.com/vision/?hl=ja

- 投稿日:2021-01-10T19:09:05+09:00

Heapqを使ってみた

はじめに

pythonのheapqというライブラリを使って,ソートを行う方法を学んだのでメモしました.

heapqとは

- heapq: ヒープキューアルゴリズムを利用できるライブラリ.ヒープキューは優先度キューの一種.全ての親の値が,その全ての子の値以下であるようなツリー構造を持ち,その構造を利用して効率的に要素を取り出す.

- キュー:複数要素の並び

- 優先度キュー:ある優先度に従って要素を取り出す仕組みを持つキュー.

ヒープキューは,主にソートに用いられる(ヒープソート).

実行時間については,

全ての値の大小を比較するバブルソートの場合,$O(N^2)$.

対して,ヒープソートの場合,$O(NlogN)$.heapqを使って,leetcodeの問題を解いてみた

import heapq class KthLargest: def __init__(self, k: int, nums: List[int]): self.heap = [] self.k = k for num in nums: self.add(num) def add(self, val: int) -> int: heapq.heappush(self.heap, val) if len(self.heap) > self.k: heapq.heappop(self.heap) return self.heap[0]

- 投稿日:2021-01-10T18:33:33+09:00

【環境構築】JDLA認定のE資格対策口座であるラビットチャレンジのPython環境をDatabricksで実施する手順

概要

日本ディープラーニング協会のDeep Learning資格試験(E資格)の対策講座であるラビットチャレンジの学習環境を、無償でブラウザにより利用可能なDatabricks Community Editionで実施したので、共有します。

ラビットチャレンジとは

Study-AI株式会社が提供している自己学習を主体的に進めることが前提で提供されている、月額3000円で提供されている格安の対策口座です。

引用元:ラビット★チャレンジ Deep Learning (ai999.careers)Databricks Community Edition

Sparkによるビッグデータ処理やPythonやRによるデータ分析を実施可能なデータ統合データプラットフォーム(レイクハウス)のサービスであるDatabricksの無償環境です。

引用元:Databricks - 統合データ分析なぜDatabricksを利用するのか

Databricksで学習しておくことで、実際の業務で利用可能するためです。

Databricksは、AWSやAzureなどのマルチクラウドで提供されており、仮想ネットワーク上にデプロイできることからエンタープライズレベルのセキュリティ要件を満たすことができます。Anacondaは有償化されてしまい利用は難しいですし、Google Colabはセキュリティという観点で業務では利用できませんでした。

必要そうな環境

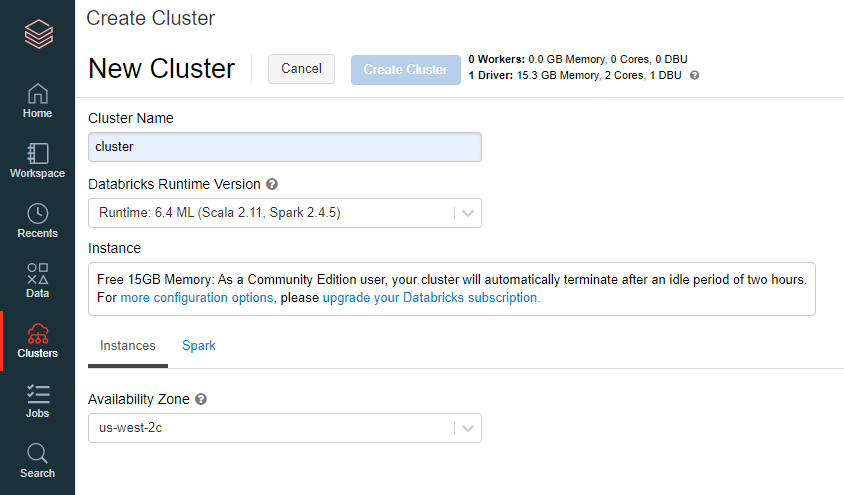

下記の環境が必要であり、最新版のDatabricks RuntimeだとKearas(スタンドアロン)がインストールされていないため、Databricks Runtime 6.4 MLを利用するのがよさそうです

- Python

- Pandas

- Numbpy

- tensolflow

- Kerasa(スタンドアロン)

Databricks Runtime 6.4 MLにインストールされているライブラリは、下記のドキュメントを参考にしてください

Databricks環境構築

Databricks Community Editonの申し込みます。

Try Databricksから申し込みを実施します。

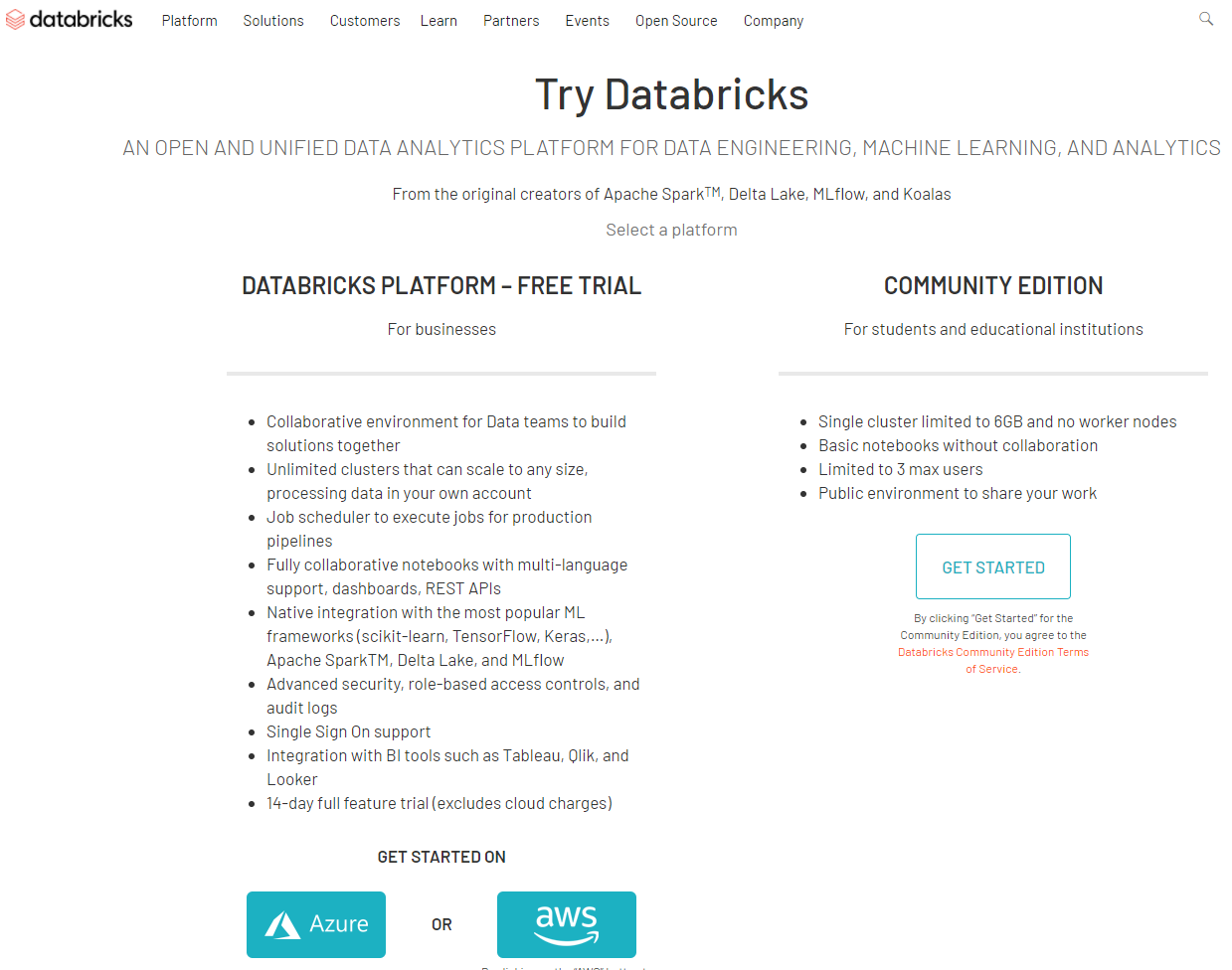

引用元:Try Databricks下記にて、"COMMUNITY EDITION"を選択します。

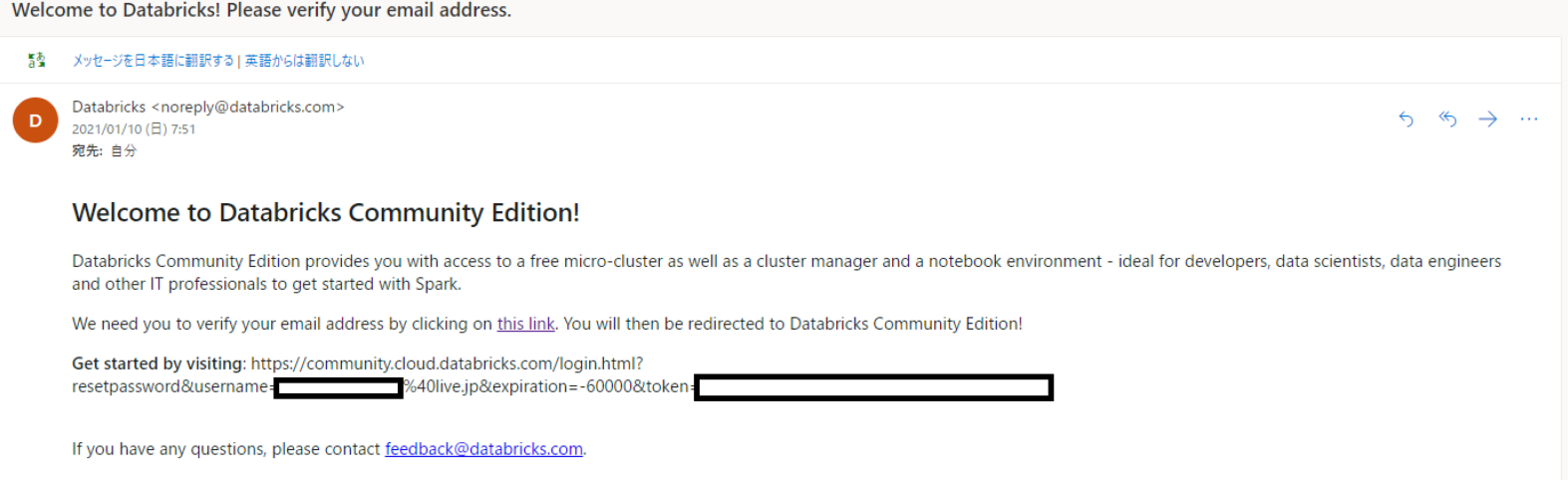

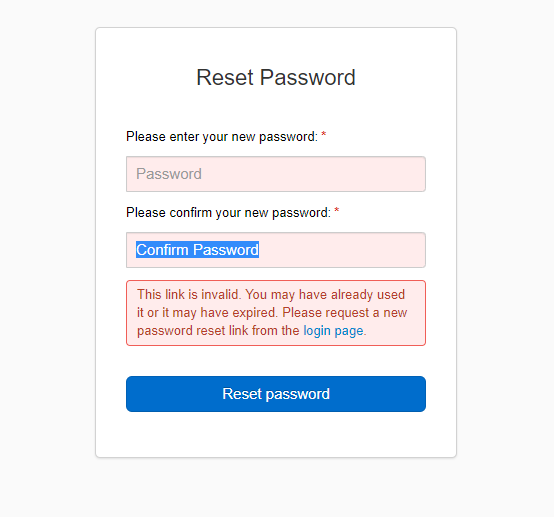

引用元:Try Databricks届いたメールのリンクを設定します。

パスワードを設定します。

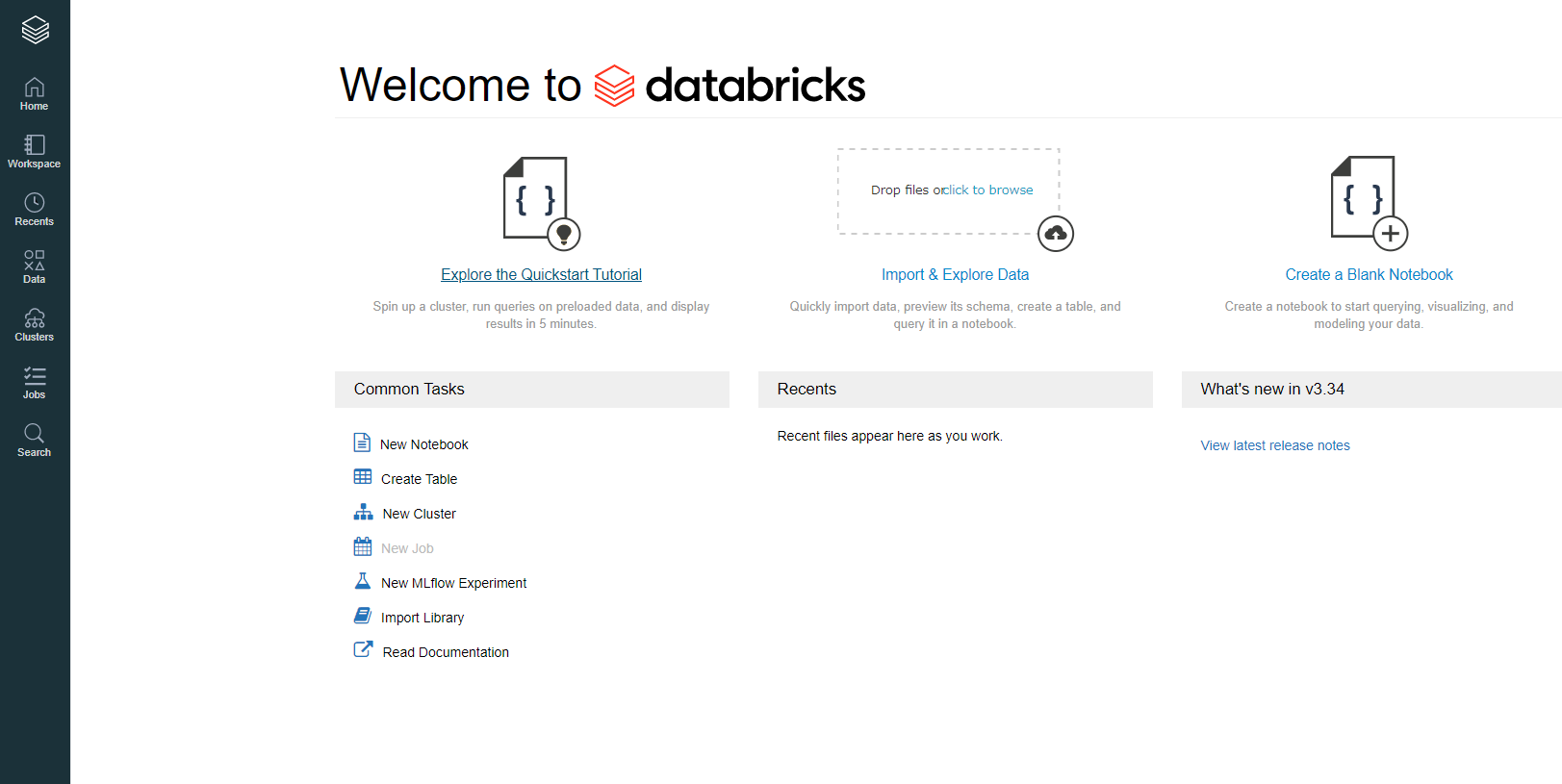

Databricksに接続できることを確認します。

講座を学習する際の手順

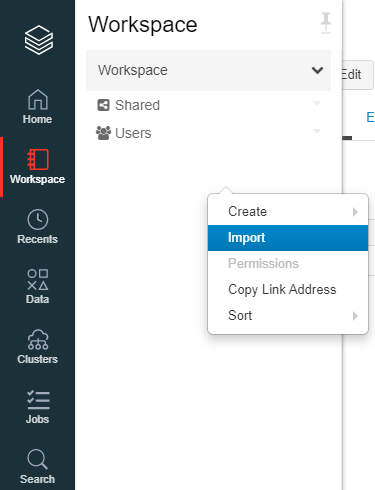

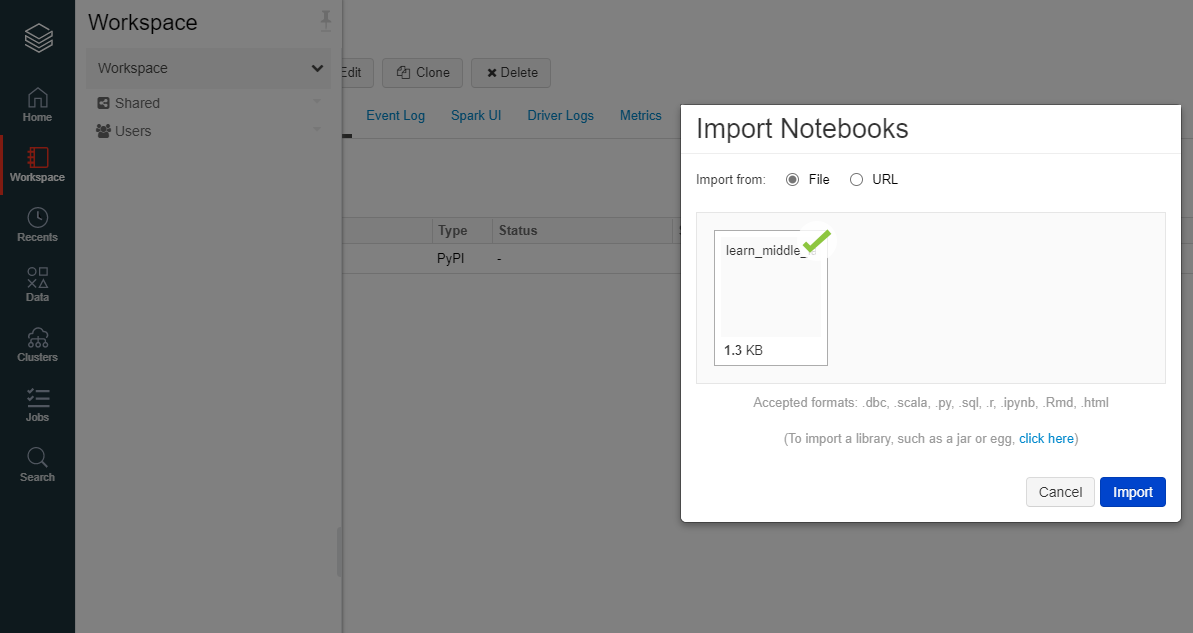

インポートするファイルをインポートします。フォルダーで取り込めないため、コマンドラインで一括で取り込んだほうが楽かもしれません。

"Clustres"を右クリック後、"Cluster Name"に適当な名前を、"Databricks Runtime Version"を"Databricks Runtime 6.4 ML(Scala 2.11 Spark 2.4.5)"を入力し、"Create Cluster"を選択。

ノートブックを開き、クラスターをアタッチして、ノートブックを実行します。

本手順で学習する場合の注意事項

- Community Editionでは、GPUを利用することはできないこと

- 学習前に毎回クラスターをクローンにより作成する必要があること

- 学習コードのインポートをGUIで実施する場合にフォルダー単位で実施する必要があること

- 投稿日:2021-01-10T18:26:11+09:00

[翻訳] SLY (Sly Lex Yacc)

Python用の字句解析器と構文解析器の生成用ライブラリである、SLYのドキュメントを和訳しました。

原文はこちらです:https://sly.readthedocs.io/en/latest/sly.html訳語の選択に、サイエンス社のコンパイラ 原理・技法・ツール I & II(初版)とbison、flexの日本語訳を参考にしました。

ありがとうございます。SLY (Sly Lex Yacc)

本ドキュメントはSLYによる字句解析処理と構文解析処理の概要を紹介する。構文解析処理は本質的に複雑なため、SLYで大規模開発に当たる前に、本ドキュメント全体を(さわりだけでも)読むことを強く推奨する。

SLYはPython 3.6以上を必要とする。より古いバージョンを使っている場合、運が悪いと諦めること。すまんね。

前置き

SLYは構文解析器やコンパイラを記述するためのライブラリである。伝統あるコンパイラ生成ツールであるlexとyaccを手本とし、それらが用いるのと同様にLALR(1)構文解析アルゴリズムを実装している。lexとyaccで使える機能の大部分はSLYにも備わっている。SLYは付加機能(たとえば抽象構文木の自動生成機能や深さ優先巡回)を十分に提供していないことに注意せよ。また、これを構文解析フレームワークと捉えるべきでない。その代わり、Pythonによる構文解析器を記述用ライブラリとして十分な骨組みであることが分るだろう。

本ドキュメントの残りの部分は、読者が構文解析器の定石、構文主導翻訳、他言語向けのlexやyacc風コンパイラ生成ツールの用法に十分慣れ親しんでいることを想定している。これらの題目に不慣れなら、たとえばAho、 Sethi、Ullmanらによる"Compilers: Principles, Techniques, and Tools(コンパイラ―原理・技法・ツール)"などの入門書に当たるべきだろう。O'Reillyから出ているJohn Levineの"Lex and Yacc"も手頃だろう。実際、SLYの参考に実質的に同じ概念のものを扱うO'Reilly本が使用できる。

SLYの概要

SLYは2つの独立したクラス

LexerとParserを提供する。Lexerクラスは入力テキストを正規表現規則によって特定されるトークン列への分割処理に使用される。Parserクラスは文脈自由文法の形式で記述される言語構文の認識処理に使用される。構文解析器の作成には、通常、この2つのクラスが併用される。もちろん、これはそうした制限ではなく、柔軟に変更する余地がある。基本的な事項を次の2つのパートで説明する。字句解析器の記述

あるプログラミング言語の記述に際し、以下の文字列を構文解析したいと仮定しよう。

x = 3 + 42 * (s - t)構文解析の第一歩は、テキストをトークンに分割する処理である。トークンはそれぞれ型と値を持つ。上記のテキストは、以下のトークンタプルのリストとして記述することができる。

[ ('ID','x'), ('EQUALS','='), ('NUMBER','3'), ('PLUS','+'), ('NUMBER','42'), ('TIMES','*'), ('LPAREN','('), ('ID','s'), ('MINUS','-'), ('ID','t'), ('RPAREN',')') ]SLYの

Lexerクラスが、これを実行する。上記のテキストをトークン分割する、単純な字句解析器のサンプルがこちら。# calclex.py from sly import Lexer class CalcLexer(Lexer): # Set of token names. This is always required tokens = { ID, NUMBER, PLUS, MINUS, TIMES, DIVIDE, ASSIGN, LPAREN, RPAREN } # String containing ignored characters between tokens ignore = ' \t' # Regular expression rules for tokens ID = r'[a-zA-Z_][a-zA-Z0-9_]*' NUMBER = r'\d+' PLUS = r'\+' MINUS = r'-' TIMES = r'\*' DIVIDE = r'/' ASSIGN = r'=' LPAREN = r'\(' RPAREN = r'\)' if __name__ == '__main__': data = 'x = 3 + 42 * (s - t)' lexer = CalcLexer() for tok in lexer.tokenize(data): print('type=%r, value=%r' % (tok.type, tok.value))これを実行すると、以下の出力が生成される。

type='ID', value='x' type='ASSIGN', value='=' type='NUMBER', value='3' type='PLUS', value='+' type='NUMBER', value='42' type='TIMES', value='*' type='LPAREN', value='(' type='ID', value='s' type='MINUS', value='-' type='ID', value='t' type='RPAREN', value=')'字句解析器は公開メソッド

tokenize()を一つだけ備えている。これは、Tokenインスタンスのストリームを生成するジェネレータ函数となっている。Tokenのtype属性とvalue属性は、それぞれトークン型名と値を保持している。tokensのセット

字句解析器は、自身によって生成される可能性のあるあらゆるトークン型名を

tokensセットで規定しておく必要がある。これは常に必須で、様々な検証処理で使用される。トークン名を規定するコードの例。

class CalcLexer(Lexer): ... # Set of token names. This is always required tokens = { ID, NUMBER, PLUS, MINUS, TIMES, DIVIDE, ASSIGN, LPAREN, RPAREN } ...トークン名はすべて大文字で指定することが推奨される。

トークン照合パターンの仕様

トークンの指定は、

reモジュールと互換性のある正規表現規則の記述で行なう。規則の名称は、tokensセットで示したトークン名のいずれか一つに対応させる必要がある。例)PLUS = r'\+' MINUS = r'-'可読性を向上させるため、正規表現パターンは

re.VERBOSEフラグをつけてコンパイルされる。このモードでは、エスケープされていない空白文字は無視され、コメントの記述も許可される。パターンに空白文字を含める場合、\sを使用する。#文字の照合には、[#]か\#を使う。

Lexerクラスにリストされたパターンの順序が、トークンの照合順序となる。長めのトークンは、短めのトークンより常に先に指定しておかれなければならない。たとえば、=と==のトークンを区別したい場合、==を先に指定する必要がある。例)class MyLexer(Lexer): tokens = { ASSIGN, EQ, ...} ... EQ = r'==' # MUST APPEAR FIRST! (LONGER) ASSIGN = r'='破棄テキスト

入力ストリーム中で無視すべき単一文字の集まりを指定するために、

ignore特殊指定が用意されている。通常、これは、空白文字やその他不要な文字の読み飛ばし処理で使用される。ignoreに文字が指定されていても、正規表現パターンの一部として含まれているその文字は無視されない。たとえば、引用符で括られたテキストの規則があるとき、そのパターンにignore指定された文字が含まれていてもおかしくない。ignoreは主として、構文解析処理の対象となるトークンの隙間にある空白文字やその他のパディングを無視するために使われる。また、名称に接頭子

ignore_付けた正規表現ルールを記述することで、それ以外のテキストパターンを破棄することができる。例えば、次の構文解析器はコメントと改行を無視する規則を備えている。# calclex.py from sly import Lexer class CalcLexer(Lexer): ... # String containing ignored characters (between tokens) ignore = ' \t' # Other ignored patterns ignore_comment = r'\#.*' ignore_newline = r'\n+' ... if __name__ == '__main__': data = '''x = 3 + 42 * (s # This is a comment - t)''' lexer = CalcLexer() for tok in lexer.tokenize(data): print('type=%r, value=%r' % (tok.type, tok.value))照合動作の追加

特定トークンの照合時に、照合に加えて何らかの追加動作を実行したい場合がある。例えば、数値の変換処理や言語の予約語の検索処理などがある。これを実施する一つの手法として、その動作をメソッドとして記述し、それを紐付ける正規表現を

@_()デコレータで付与する。@_(r'\d+') def NUMBER(self, t): t.value = int(t.value) # Convert to a numeric value return tこのメソッドは単一引数を持ち、

Token型のインスタンスを受け取る。規定動作では、t.typeにトークンの名称('NUMBER'など)が格納されている。必要に応じ、函数内でトークン型やトークン値を変更して良い。最後に、戻り値として処理後のトークンが返される必要がある。函数が戻り値を返さない場合、そのトークンは破棄され、次のトークンが読み込まれる。

@_()デコレータはLexerクラス内に自動的に定義される。このため、importなどは不要である。正規表現規則を複数持たせても良い。例:@_(r'0x[0-9a-fA-F]+', r'\d+') def NUMBER(self, t): if t.value.startswith('0x'): t.value = int(t.value[2:], 16) else: t.value = int(t.value) return t

@_()デコレータを使用する代わりに、文字列で指定したトークンと同名のメソッドを直後に記述してもよい。例:NUMBER = r'\d+' ... def NUMBER(self, t): t.value = int(t.value) return tこの手法は字句解析器のデバッグで役立つ可能性がある。メソッドをトークンに一時的に紐付け、トークン出現時にそれを実行させることができる。用が済んだらそのメソッドを取り除き、字句解析器の挙動を元に戻すことができる。

トークンの再割り当て

特定条件の下でトークンの再割り当てが必要になる場合がある。"abc"、"python"、"guido"などの識別子を照合する場合を考えてみよう。"if"、"else"、"while"など特定の識別子は、特殊キーワードとして扱われるべきである。字句解析器の記述にトークン再割り当て規則を含めることで、これを実現できる。

# calclex.py from sly import Lexer class CalcLexer(Lexer): tokens = { ID, IF, ELSE, WHILE } # String containing ignored characters (between tokens) ignore = ' \t' # Base ID rule ID = r'[a-zA-Z_][a-zA-Z0-9_]*' # Special cases ID['if'] = IF ID['else'] = ELSE ID['while'] = WHILE識別子の解析時に、この特例が特定トークンの照合値を新しいトークン型で置き換える。上の例では、識別子の値が"if"の場合に

IFトークンが生成される。行番号と位置の追跡

規定動作では、字句解析器は行番号について何も関知しない。字句解析器に入力の"行"に関する定義(たとえば改行文字や、そもそも入力がテキストデータかどうかなど)が与えられていない、というのがその理由である。そうした情報を与えるために、改行に関する特例指定を追加してもい。

ignore_newline特例でこれを実施してみよう。# Define a rule so we can track line numbers @_(r'\n+') def ignore_newline(self, t): self.lineno += len(t.value)特例により、字句解析器のlineno属性が更新されるようになった。行番号が更新された後、何も返していないためそのトークンは破棄される。

字句解析器は桁位置追跡に類することを自動で行なわない。その代わり、トークンの

index属性に個々のトークンの位置情報を記録する。これを使用することで。桁位置を算出できる可能性がある。たとえば、直前の改行が見つかるまで後方検索を行なっても良い。# Compute column. # input is the input text string # token is a token instance def find_column(text, token): last_cr = text.rfind('\n', 0, token.index) if last_cr < 0: last_cr = 0 column = (token.index - last_cr) + 1 return column桁位置情報はエラー処理の文脈でのみ必要とされる。このため桁位置の計算処理は各トークンに対してではなく、必要に応じて実施できるようになっている。

文字定数

文字定数をクラスの

literalsセットで定義することができる。例)class MyLexer(Lexer): ... literals = { '+','-','*','/' } ...文字定数は、字句解析器から遭遇した"まま"の状態で返される、単なる単一文字である。文字定数は、定義済み正規表現規則すべての後に確認される。そのため、文字定数のいずれか一文字を先頭に持つルールは、文字定数より優先される。

文字定数は、その返却時に

type属性とvalue属性にその文字自身が格納される。 例)'+'定数が照合された時に実行される追加動作として、トークンメソッドを記述することができる。ただし、そのトークンメソッドは適切なトークン型を設定するように実装されなければならない。例:

class MyLexer(Lexer): literals = { '{', '}' } def __init__(self): self.nesting_level = 0 @_(r'\{') def lbrace(self, t): t.type = '{' # Set token type to the expected literal self.nesting_level += 1 return t @_(r'\}') def rbrace(t): t.type = '}' # Set token type to the expected literal self.nesting_level -=1 return tエラー処理

字句解析中に不正な文字が検出されると、字句解析処理は停止する。これに対し、字句解析エラーを処理する

error()メソッドを追加することができる。エラー処理メソッドはTokenを一つ受け取る。このトークンのvalue属性には、トークン化される前のテキスト全体が格納されている。典型的なハンドラーは、このテキストを見て、何らかの方法で読み飛ばし処理を行なう。例:class MyLexer(Lexer): ... # Error handling rule def error(self, t): print("Illegal character '%s'" % t.value[0]) self.index += 1このケースでは、そこで問題となっている文字を印字し、字句解析の位置情報を更新することで1文字の読み飛ばし処理を実施する。解析器のエラー処理は、多くの場合、難しい問題を引き起こす。エラー処理では、セミコロン、空行や、それに類する記号といった、論理的に判断できる同期箇所までの読み飛ばし処理が必要になるだろう。

error()メソッドが未処理のトークンを返すと、ストリームにERRORトークンが出現する。これは、構文解析器がエラートークンを確認したい場合、たとえば、エラーメッセージの改良やその他エラー処理を行なうのに役立つ。より完全な例

参考用に、これらの多くの概念を実践するより完全な例を示す。

# calclex.py from sly import Lexer class CalcLexer(Lexer): # Set of token names. This is always required tokens = { NUMBER, ID, WHILE, IF, ELSE, PRINT, PLUS, MINUS, TIMES, DIVIDE, ASSIGN, EQ, LT, LE, GT, GE, NE } literals = { '(', ')', '{', '}', ';' } # String containing ignored characters ignore = ' \t' # Regular expression rules for tokens PLUS = r'\+' MINUS = r'-' TIMES = r'\*' DIVIDE = r'/' EQ = r'==' ASSIGN = r'=' LE = r'<=' LT = r'<' GE = r'>=' GT = r'>' NE = r'!=' @_(r'\d+') def NUMBER(self, t): t.value = int(t.value) return t # Identifiers and keywords ID = r'[a-zA-Z_][a-zA-Z0-9_]*' ID['if'] = IF ID['else'] = ELSE ID['while'] = WHILE ID['print'] = PRINT ignore_comment = r'\#.*' # Line number tracking @_(r'\n+') def ignore_newline(self, t): self.lineno += t.value.count('\n') def error(self, t): print('Line %d: Bad character %r' % (self.lineno, t.value[0])) self.index += 1 if __name__ == '__main__': data = ''' # Counting x = 0; while (x < 10) { print x: x = x + 1; } ''' lexer = CalcLexer() for tok in lexer.tokenize(data): print(tok)このコードを実行すると、次のような出力が得られる。

Token(type='ID', value='x', lineno=3, index=20) Token(type='ASSIGN', value='=', lineno=3, index=22) Token(type='NUMBER', value=0, lineno=3, index=24) Token(type=';', value=';', lineno=3, index=25) Token(type='WHILE', value='while', lineno=4, index=31) Token(type='(', value='(', lineno=4, index=37) Token(type='ID', value='x', lineno=4, index=38) Token(type='LT', value='<', lineno=4, index=40) Token(type='NUMBER', value=10, lineno=4, index=42) Token(type=')', value=')', lineno=4, index=44) Token(type='{', value='{', lineno=4, index=46) Token(type='PRINT', value='print', lineno=5, index=56) Token(type='ID', value='x', lineno=5, index=62) Line 5: Bad character ':' Token(type='ID', value='x', lineno=6, index=73) Token(type='ASSIGN', value='=', lineno=6, index=75) Token(type='ID', value='x', lineno=6, index=77) Token(type='PLUS', value='+', lineno=6, index=79) Token(type='NUMBER', value=1, lineno=6, index=81) Token(type=';', value=';', lineno=6, index=82) Token(type='}', value='}', lineno=7, index=88)この例をもう少し掘り下げてみよう。解釈に時間がかかるかもしれないが、字句解析器の記述の要点が、すべてここに示されている。トークンは正規表現ルールで指定されなければならない。一定のパターンが検出された場合に実行される動作を付随させることができる。文字定数などのいくつかの機能により、正規表現ルールを個別に作成する手間を省ける。また、エラー処理を追加することもできる。

構文解析器の記述

Parserクラスは言語構文の構文解析に使用される。例を示す前に、押さえておくべき背景知識がいくつか存在する。構文解析の背景知識

構文解析器の記述を行う際、通常、構文はBNF記法で定義される。たとえば単純な数式を構文解析する場合、最初に、曖昧さを排除した次のような文法仕様を記述する。

expr : expr + term | expr - term | term term : term * factor | term / factor | factor factor : NUMBER | ( expr )文法の中にある

NUMBER、+、-、*、/などの記号は終端記号と呼ばれ、生の入力トークンに対応している。term、factorなどの識別子は、終端記号の集合とその他規則で構成される文法規則を参照する。これらの識別子は 非終端記号として知られている。文法を複数の階層(expr、termなど)に分割することで、扱いが異なる演算子の優先順位規則を組み込むことができる。この例では、乗算と除算の方が加算と減算よりも優先される。構文解析の中で生じる意味(semantics)は、多くの場合、構文主導翻訳として知られる手法で定義される。構文主導翻訳において、文法の中にある記号は一つの対象物として扱われる。各種文法規則が認識されると、値が記号に割り当てられ、それらの値に対する操作が実行される。先に取り上げた数式の文法が与えられたとき、以下のようにして、単純な計算機の計算処理を以下のように記述できる。

Grammar Action ------------------------ -------------------------------- expr0 : expr1 + term expr0.val = expr1.val + term.val | expr1 - term expr0.val = expr1.val - term.val | term expr0.val = term.val term0 : term1 * factor term0.val = term1.val * factor.val | term1 / factor term0.val = term1.val / factor.val | factor term0.val = factor.val factor : NUMBER factor.val = int(NUMBER.val) | ( expr ) factor.val = expr.valこの文法において、新しい値は

NUMBERトークンを通して導入される。これらの値は上で示した動作によって伝搬される。例えば、factor.val = int(NUMBER.val)がNUMBERの値をfactorへ伝搬する。term0.val = factor.valがfactorの値をtermに伝搬する。expr0.val = expr1.val + term1.valのような規則が値の結合を実施し、更にその先へと値を伝搬する。数式2 + 3 * 4のなかで値がどのように伝搬されていくかを以下に示す。NUMBER.val=2 + NUMBER.val=3 * NUMBER.val=4 # NUMBER -> factor factor.val=2 + NUMBER.val=3 * NUMBER.val=4 # factor -> term term.val=2 + NUMBER.val=3 * NUMBER.val=4 # term -> expr expr.val=2 + NUMBER.val=3 * NUMBER.val=4 # NUMBER -> factor expr.val=2 + factor.val=3 * NUMBER.val=4 # factor -> term expr.val=2 + term.val=3 * NUMBER.val=4 # NUMBER -> factor expr.val=2 + term.val=3 * factor.val=4 # term * factor -> term expr.val=2 + term.val=12 # expr + term -> expr expr.val=14SLYは、LR構文解析、または、移動還元構文解析(shift-reduce parsing)として知られる構文解析技法を使用する。LR構文解析法は、様々な文法規則の右辺の認識を試行する、ボトムアップ手法である。入力されたものの中に(文法定義の)右辺に適合するものが見つかると、それに沿った動作メソッドが実行され、右辺に相当する文法記号群が左辺の文法記号で置換される。

LR構文解析は、一般的に、文法記号をスタックに移動(shift)する処理と、スタックと次の入力が文法規則の型にはまるかどうかを試行する処理で実装されている。アルゴリズムの詳細はコンパイラの教科書を見れば分るだろう。次の例は数式

3 + 5 * (10 - 20)を上で定義した文法で構文解析する過程を示す。この例のなかで、特殊記号$は入力の終端を示す。---- --------------------- --------------------- ------------------------------- 1 3 + 5 * ( 10 - 20 )$ Shift 3 2 3 + 5 * ( 10 - 20 )$ Reduce factor : NUMBER 3 factor + 5 * ( 10 - 20 )$ Reduce term : factor 4 term + 5 * ( 10 - 20 )$ Reduce expr : term 5 expr + 5 * ( 10 - 20 )$ Shift + 6 expr + 5 * ( 10 - 20 )$ Shift 5 7 expr + 5 * ( 10 - 20 )$ Reduce factor : NUMBER 8 expr + factor * ( 10 - 20 )$ Reduce term : factor 9 expr + term * ( 10 - 20 )$ Shift * 10 expr + term * ( 10 - 20 )$ Shift ( 11 expr + term * ( 10 - 20 )$ Shift 10 12 expr + term * ( 10 - 20 )$ Reduce factor : NUMBER 13 expr + term * ( factor - 20 )$ Reduce term : factor 14 expr + term * ( term - 20 )$ Reduce expr : term 15 expr + term * ( expr - 20 )$ Shift - 16 expr + term * ( expr - 20 )$ Shift 20 17 expr + term * ( expr - 20 )$ Reduce factor : NUMBER 18 expr + term * ( expr - factor )$ Reduce term : factor 19 expr + term * ( expr - term )$ Reduce expr : expr - term 20 expr + term * ( expr )$ Shift ) 21 expr + term * ( expr ) $ Reduce factor : (expr) 22 expr + term * factor $ Reduce term : term * factor 23 expr + term $ Reduce expr : expr + term 24 expr $ Reduce expr 25 $ Success!数式の構文解析を行なう時、背後にある状態機械と手元の入力トークンによって次の動作が決定される。次のトークンが(スタック上の要素と併せて)有効な文法規則の一部として見なされると、そのトークンはスタック上に移動される(積まれる)。スタックの先頭部分が文法ルールの右辺に適合すると、それが"還元(reduce)"され、それらの記号群が左辺のシンボルに置き換えられる。この還元が発生したときに、それに対応する動作が(あれば)実行される。入力トークンが移動されず、スタックの先頭がいずれの文法規則にも適合しない場合、構文エラーが発生し、構文解析器は復旧手順をとるか救済処置を行なう必要がある。構文解析スタックが空でかつ入力トークンがなくなったとき、唯一、構文解析が成功したものとみなされる。

裏側にある巨大な有限状態機械が、巨大な表の集まりで実装されていることに留意しなければならない。これらの表の構成法は単純ではなく、説明の範囲を超えている。この上の例9段階目で構文解析器が

expr : expr + termを還元する代わりにトークンをスタックに移動するその理由は、手順の詳細を見ることで解き明かされる。構文解析の例

先に紹介したような単純な算術計算式を評価する構文解析器を作成したいと仮定する。SLYでそれを実現するにはこのようにする。

from sly import Parser from calclex import CalcLexer class CalcParser(Parser): # Get the token list from the lexer (required) tokens = CalcLexer.tokens # Grammar rules and actions @_('expr PLUS term') def expr(self, p): return p.expr + p.term @_('expr MINUS term') def expr(self, p): return p.expr - p.term @_('term') def expr(self, p): return p.term @_('term TIMES factor') def term(self, p): return p.term * p.factor @_('term DIVIDE factor') def term(self, p): return p.term / p.factor @_('factor') def term(self, p): return p.factor @_('NUMBER') def factor(self, p): return p.NUMBER @_('LPAREN expr RPAREN') def factor(self, p): return p.expr if __name__ == '__main__': lexer = CalcLexer() parser = CalcParser() while True: try: text = input('calc > ') result = parser.parse(lexer.tokenize(text)) print(result) except EOFError: breakこの例では、各文法規則は

@_(rule)によってデコレートされたメソッドとして記述されている。一番最初の文法規則(BNF記法の中で最初の規則)は、構文解析の最上位を定義する。各メソッドの名称は、構文解析対象となる文法ルールの名称と一致している必要がある。@_()デコレータの引数には、文法の右辺を記述する文字列文字列となっている。以下のような文法規則は、expr : expr PLUS termこのようなメソッドになる。

Python

@_('expr PLUS term')

def expr(self, p):

...

入力の中で文法規則が認識されると、そのメソッドが起動される。メソッドは文法記号値のシーケンスを引数

pで受け取る。これらのシンボルを参照する方法が二つある。一つ目は、以下のようにシンボル名を使用する。@_('expr PLUS term') def expr(self, p): return p.expr + p.term他にも、配列と同じようにpのインデックスを扱える。

@_('expr PLUS term') def expr(self, p): return p[0] + p[2]トークンの

p.symbolやp[i]には、構文解析器がトークンに割り当てるp.value属性と同じ値が割り当てられている。非終端記号では、規則の中でメソッドに返された値になっている。文法規則に同じ記号名が複数含まれている場合、記号名を明確に区別するために数字を末尾に追加する必要がある。例:

@_('expr PLUS expr') def expr(self, p): return p.expr0 + p.expr1最後に、各規則内で値を返却し、文法記号に対応させる必要がある。このようにして、文法内で値が伝搬される。

文法の中で、これとは違う種類の動作をしても良い。たとえば、文法定義で構文木の一部を生成しても良い。

@_('expr PLUS term') def expr(self, p): return ('+', p.expr, p.term)また、抽象構文木に関連したインスタンスを作成しても良い。

class BinOp(object): def __init__(self, op, left, right): self.op = op self.left = left self.right = right @_('expr PLUS term') def expr(self, p): return BinOp('+', p.expr, p.term)記号(ここでは"expr")に関連付けする値をメソッドが返すことが大切である。これは前節で示した値の伝搬である。

文法規則函数の組み合わせ

文法規則が似ている場合、単一のメソッドに統合しても良い。たとえば、1つの構文木を生成する規則が2つ存在するとしよう。

Python

```

@_('expr PLUS term')

def expr(self, p):

return ('+', p.expr, p.term)@_('expr MINUS term')

def expr(self, p):

return ('-', p.expr, p.term)

```2つの函数の代わりに、単一の函数を以下のように記述しても良い。

@_('expr PLUS term', 'expr MINUS term') def expr(self, p): return (p[1], p.expr, p.term)この例では、演算子は

PLUSかMINUSのどちらかになる。シンボル名を値として使用することはできないので、代わりにp[1]のように配列操作を行なうとよい。一般的に、 あるメソッドの

@_()デコレータに複数の文法規則を与えることが許される。単一函数に複数の文法ルールを組み込む場合、すべての規則が同じ構造をとっている(例えば、項とシンボル名の数が一致している)必要がある。さもないと、それを対処するアクションコードが必要以上に複雑になる可能性がある。文字リテラル

必要に応じ、文法に単一文字からなるトークンを含めることができる。例:

@_('expr "+" term') def expr(self, p): return p.expr + p.term @_('expr "-" term') def expr(self, p): return p.expr - p.term文字リテラルは、必ず

"+"のように引用服で括る必要がある。加えて、対応する字句解析器クラスのliteralsでそれらを宣言しておく必要がある。class CalcLexer(Lexer): ... literals = { '+','-','*','/' } ...文字定数は、単一文字に限られる。つまり、

<=、==のような定数の指定は合法ではない。こうした定数は、通常の字句解析規則に従う必要がある(たとえば、LE = r'<='のような規則を定義する)。空の生成規則

何も生成したくない場合、以下のような規則を定義する。

@_('') def empty(self, p): pass空の生成規則を使用する場合、"empty" という名前をシンボルとして使用するとよい。省略可能な要素を規則に組み込む必要がある場合、以下のようにする。

spam : optitem grok optitem : item | emptySLYでは以下のように組み込む。

@_('optitem grok') def spam(self, p): ... @_('item') def optitem(self, p): ... @_('empty') def optitem(self, p): ...注:空の文字列を指定することで、どこにでも空のルールを記述できる。一方、"empty"規則を記述し、それが何も生成しない"空"であることを明記することで、可読性が上がり、意図がより明確に示される。

曖昧な文法の対処法

先に示した数式の文法は、曖昧さを排除するため特別な書式で記述されている。しかし、多くの場合、この書式で文法を記述するのはとても困難かつ厄介なものになる。より自然な文法の記法は、以下のようなコンパクトな記法である。

expr : expr PLUS expr | expr MINUS expr | expr TIMES expr | expr DIVIDE expr | LPAREN expr RPAREN | NUMBER残念なことに、この文法仕様には曖昧さがある。例えば、文字列"3 * 4 + 5"を構文解析するとき、演算子がどのようにグループ化されるかを判断する方法がない。この式は"(3 * 4) + 5"だろうか、さもなくば"3 * (4+5)"だろうか?

曖昧な文法が与えられると、"shift/reduce conflicts"や"reduce/reduce conflicts"といったメッセージが表示される。shift/reduce conflict(シフト/還元衝突)は、構文解析器生成器が規則を還元するか、解析スタック上のシンボルをシフトするかを判断できない場合に発生する。例えば、文字列"3 * 4 + 5"の構文解析の内部スタックを考えてみよう。

Step Symbol Stack Input Tokens Action ---- ------------- ---------------- ------------------------------- 1 $ 3 * 4 + 5$ Shift 3 2 $ 3 * 4 + 5$ Reduce : expr : NUMBER 3 $ expr * 4 + 5$ Shift * 4 $ expr * 4 + 5$ Shift 4 5 $ expr * 4 + 5$ Reduce: expr : NUMBER 6 $ expr * expr + 5$ SHIFT/REDUCE CONFLICT ????この例の構文解析器は、6番目の段階に到達したとき、2つの選択肢がある。一つは、規則

expr : expr * exprをスタック上で還元することである。もう一つの選択肢は、トークン+をスタックに移動することである。両選択肢とも、文脈自由文法の規則上完全に合法である。通常、すべての移動/還元衝突は移動の選択によって解決される。それ故に、上記の例の構文解析器は、+を還元せずに移動する。この戦略は多くの場合上手く働く(たとえば"if-then"と"if-then-else")が、算術計算式ではそうならない。実際、上記の例において、+の移動は完全に誤りである。乗算は加算より算術の優先順位が高く、

expr * exprの還元を選択するべきである。特に計算式の文法において、曖昧さを解決するために、SLYはトークンに対し優先順位と結合規則の割り当てを許している。これを実現するには、構文解析器クラスに変数

precedenceを追加すれば良い。class CalcParser(Parser): ... precedence = ( ('left', PLUS, MINUS), ('left', TIMES, DIVIDE), ) # Rules where precedence is applied @_('expr PLUS expr') def expr(self, p): return p.expr0 + p.expr1 @_('expr MINUS expr') def expr(self, p): return p.expr0 - p.expr1 @_('expr TIMES expr') def expr(self, p): return p.expr0 * p.expr1 @_('expr DIVIDE expr') def expr(self, p): return p.expr0 / p.expr1 ...この

precedence指定はPLUS/MINUSが同じ優先順位で左結合、TIMES/DIVIDEが同じ優先順位で左結合であることを指定している。precedence指定の中で、トークンは底優先度から高い優先度の順に並べられる。従って、この指定は、優先度指定の後部にあるTIMES/DIVIDEがPLUS/MINUSより高い優先度を持つことを指定している。優先順位指定は、優先順位レベル値や結合方向をトークンに関連付けることによって機能する。たとえば、上記の例では以下が得られる。

PLUS : level = 1, assoc = 'left' MINUS : level = 1, assoc = 'left' TIMES : level = 2, assoc = 'left' DIVIDE : level = 2, assoc = 'left'次に、これらの数値は、優先順位レベル値や結合方向を個々の分布規則に付与するために使用される。_常にこれらは右端の終端記号の値によって決定される。例:

expr : expr PLUS expr # level = 1, left | expr MINUS expr # level = 1, left | expr TIMES expr # level = 2, left | expr DIVIDE expr # level = 2, left | LPAREN expr RPAREN # level = None (not specified) | NUMBER # level = None (not specified)移動/還元衝突が発生すると、構文解析器生成器は優先順位規則や結合の指定を用いて衝突の解決を行なう。

- 現在のトークンがスタック上の規則より高い優先順位を持つ場合、それは移動される。

- スタック上の文法規則が高い優先順位を持つ場合、それは還元される。

- 現在のトークンと文法規則が同じ優先順位を持つ場合、左結合であれば規則が還元され、右結合であればトークンは移動される。

- 優先順位についての情報が存在しない場合、移動/還元衝突は規定動作の移動によって解決される。

たとえば、

expr PLUS exprが構文解析された次のトークンとしてTIMESが来たとする。TIMESの優先順位レベルはPLUSより高いため、移動が行なわれる。逆に、expr TIMES exprが構文解析され次のトークンとしてPLUSが来たとする。PLUSの優先順位はTIMESより低いため、還元が行なわれる。優先順位規則があっても三番目の手法で移動/還元衝突が解決されたときSLYはエラーや衝突を報告しない。

優先順位指定の手法には一つ問題がある。特定の文脈で優先順位を変えたくなる場合がある。たとえば、

3 + 4 * -5にある単項マイナス演算子を考えよう。数学的には、単項マイナスは通常非常に高く、優先順位–乗算の前に評価される。しかしながら、我々の優先順位指定では、MINUSはTIMESより低い優先順位を持っている。これに対処するため、"架空のトークン"と呼ばれる優先順位規則を与えることができる。class CalcParser(Parser): ... precedence = ( ('left', PLUS, MINUS), ('left', TIMES, DIVIDE), ('right', UMINUS), # Unary minus operator )ここで、文法ファイルに単項マイナスの規則を記述する。

@_('MINUS expr %prec UMINUS') def expr(p): return -p.exprこの例では、

%prec UMINUSが規定規則による優先順位設定を、UMINUSの優先順位で上書きする。初見だと、この例にある

UMINUSの用法が、非常に紛らわしく見えるかもしれない。UMINUSは入力トークンでも文法規則でもない。これは、優先順位表の中の特殊マーカーに付けた名称と考えると良い。%prec修飾子を使用するとき、SLYに対し、その式の優先順位を通常の優先順位ではなく、特殊マーカーの優先順位と同様とするよう伝えていることになる。また、優先順位表の中で、結合なしを指定することもできる。このやり方は、演算子同士を連続して使いたくないときに使われる。たとえば、

<と>の比較演算子をサポートしたいが、a < b < cのような組み合わせは求めていないと仮定する。このために、優先順位を以下のように指定する。... precedence = ( ('nonassoc', LESSTHAN, GREATERTHAN), # Nonassociative operators ('left', PLUS, MINUS), ('left', TIMES, DIVIDE), ('right', UMINUS), # Unary minus operator )こうすることで、

a < b < cのような入力テキストに対し、構文エラーが生成される。もちろん、a < bのような単純な式に対してはうまくいく。還元/還元衝突は、与えられた記号のセットに対し、複数の文法規則が適用可能なときに引き起こされる。この類いの衝突はほぼ必ず間違いである。この衝突は文法ファイルの中で最初に現れた規則によって解決される。異なる文法規則の集合が、何らかの形で同じ記号のセットを生成しようとする場合に、還元/還元衝突が発生する。例:

assignment : ID EQUALS NUMBER | ID EQUALS expr expr : expr PLUS expr | expr MINUS expr | expr TIMES expr | expr DIVIDE expr | LPAREN expr RPAREN | NUMBERこの例では、2つの規則の間で還元/還元衝突が存在する。

assignment : ID EQUALS NUMBER expr : NUMBERたとえば、

a = 5を構文解析しているとき、構文解析器はassignment : ID EQUALS NUMBERを還元するべきか、または5をexpressionとして還元してさらにassignment : ID EQUALS expr規則を還元するべきかを特定できない。文法から還元/還元衝突を見つけ出すのが難しい、ということは周知の事実である。還元/還元衝突が発生すると、SLYは以下のような警告文を出して、助けを求める。

WARNING: 1 reduce/reduce conflict WARNING: reduce/reduce conflict in state 15 resolved using rule (assignment -> ID EQUALS NUMBER) WARNING: rejected rule (expression -> NUMBER)このメッセージは、衝突状態にある規則が2つ存在することを特定している。しかし、なぜ構文解析器がそのような結論を出したかについて、このメッセージはなにも伝えてくれない。これを特定するためには、適度に高濃度なカフェイン添加を以て、文法と、構文解析器のデバッグファイルの内容を調べる必要があるだろう。

構文解析器のデバッグ

LR構文解析アルゴリズムの使用の中でも、移動/還元衝突と還元/還元衝突の掘り下げは歓喜の一言に尽きる。デバッグ処理を支援するため、SLYの構文解析表の作成時にデバッグファイルを出力させることができる。これには、クラスに

debugfile属性を追加する。class CalcParser(Parser): debugfile = 'parser.out' ...このようにすると、指定したファイルに文法全体と、構文解析の状態が出力される。構文解析器の状態は以下のような形式で出力される。

state 2 (7) factor -> LPAREN . expr RPAREN (1) expr -> . term (2) expr -> . expr MINUS term (3) expr -> . expr PLUS term (4) term -> . factor (5) term -> . term DIVIDE factor (6) term -> . term TIMES factor (7) factor -> . LPAREN expr RPAREN (8) factor -> . NUMBER LPAREN shift and go to state 2 NUMBER shift and go to state 3 factor shift and go to state 1 term shift and go to state 4 expr shift and go to state 6状態は、その時点で照合過程の一部となり得る文法規則の追跡をする。各規則の中で、その規則の構文解析における現在位置が文字"."で示される。他にも、有効な入力トークンに対応する動作が一覧化されている。(若干の練習が必要だが、)これら規則を調査することで、構文解析における衝突を追跡することができるようになる。すべての移動/還元衝突が間違いとは限らないことを、強調しておこう。それらが正しく解決されることを確認する方法は、デバッグファイルの調査しかない。

構文エラー処理

業務用途の構文解析器を作成する場合、構文エラー処理を疎かにしてはならない。誰も、問題の兆候が出ただけでお手上げ状態になるような構文解析器を求めていない。そうす代わりに、入力に含まれる複数のエラーが利用者にまとめて報告される方が望ましい。そのためには、エラーを報告し、可能なら回復し、構文解析処理を継続させる必要がある。これは、C、C++、Javaなどの言語のコンパイラで見られる、ありふれた振る舞いである。

SLYでは、構文解析中に構文エラーが発生すると、そのエラーは即座に検出される(つまり、構文解析器はエラーの原因となる箇所を超えてトークンを読み取ることをしない)。その時点で構文解析器が復旧モードに入るため、そこで構文解析を継続するための試みが可能である。一般的に、LR構文解析器内でのエラー回復処理は古代の技術と黒魔術を含む繊細なトピックである。SLYによって提供される復旧の仕組みはUnix yaccに匹敵しており、その詳細はO'Reillyの"Lex and Yacc"を参照すると良い。

構文エラーが発生すると、SLYは以下の手順を実施する。

- エラーが発生したとき、最初に

error()メソッドが問題のトークンを引数にとって呼び出される。end-of-fileの到達による構文エラーでは、代わりにNoneが渡される。そして構文解析器は"エラー回復"モードに入り、少なくとも3つのトークンが構文解析スタック上で移動に成功するまでerror()メソッドの呼び出しは行なわれなくなる。error()で回復動作が行なわれない場合、問題となっている先読トークンは特殊なerrorトークンに置き換えられる。- 問題のある先読みトークンが既に

errorトークンに設定されると、構文解析スタックの先頭要素が削除される。- 構文解析スタックが巻き戻されると、構文解析器は再起動状態に入り、初期状態からの構文解析の開始を試みる。

- 文法規則が

errorをトークンとして受容する場合、構文解析スタックにそれが移動される。- 構文解析スタックの先頭が

errorとなった場合、構文解析器によって新しい記号が移動されるかerrorに巻き込まれた規則が還元されるまで、先読みトークンが破棄されていく。エラー規則による回復処理と再同期

格調高い構文エラー処理を試みるには、文法規則内に

errorトークンを組み込むことである。print文の文法規則を持つとある言語を考えてみよう。@_('PRINT expr SEMI') def statement(self, p): ...記述に問題がある可能性を考慮し、以下のような文法規則を追加しても良い。

@_('PRINT error SEMI') def statement(self, p): print("Syntax error in print statement. Bad expression")この例の

errorトークンは、セミコロンが出現するまでの何らかのトークン列を照合する。セミコロンに到達するとその規則が呼び出され、errorトークンは消失する。この種の回復処理は、構文解析の再同期処理と呼ばれることもある。

errorトークンは不正な入力テキストに対するワイルドカードとして機能し、errorトークンの直後にあるトークンが同期トークンとして動作する。

errorがエラー規則の最右端トークンとしておかれることは、通常あり得ないことに留意しよう。例:@_('PRINT error') def statement(self, p): print("Syntax error in print statement. Bad expression")不正なトークンの先頭要素が規則を発動し移動の対象となるため、不正なトークンが連続していると復旧をより難しいものにしてしまう、というのがその理由である。セミコロン、閉じ括弧、その他同期点として使用できる境界の区切りをいくつか用意しておくとよい。

パニックモ-ド回復処理

別のエラー回復策として、それなりの手段で構文解析器が回復できる箇所までトークンを破棄する、パニックモード回復処理がある。

パニックモード回復処理は、そのすべてが

error()函数として実装される。たとえば、次の函数は閉じ括弧'}'に達するまでトークンを捨てる。その後、構文解析器は初期状態から再開する。def error(self, p): print("Whoa. You are seriously hosed.") if not p: print("End of File!") return # Read ahead looking for a closing '}' while True: tok = next(self.tokens, None) if not tok or tok.type == 'RBRACE': break self.restart()この函数は不正なトークンを破棄し、構文解析器にエラーから回復したことを伝える。

def error(self, p): if p: print("Syntax error at token", p.type) # Just discard the token and tell the parser it's okay. self.errok() else: print("Syntax error at EOF")使用されている属性とメソッドについての詳細を示す。

self.errok()これは構文解析器をリセットし、すでにエラー回復モードではないことを示す。これによりerrorトークン生成の抑止と内部カウンターリセットを実施し、別の構文エラーが見つかったときに再度error()を呼び出せるようにする。self.tokensこれは構文解析対象の列挙可能なシーケンスとなっている。next(self.tokens)を呼ぶことで、一つ先のトークンへと進ませる。self.restart()構文解析スタックをすべて破棄し、構文解析器を初期状態へリセットする。

error()はトークンを一つ返すことにより、構文解析器に次の先読みトークンを渡すことができる。これは、特定文字での同期を試みる際に役立つ。例:def error(self, tok): # Read ahead looking for a terminating ";" while True: tok = next(self.tokens, None) # Get the next token if not tok or tok.type == 'SEMI': break self.errok() # Return SEMI to the parser as the next lookahead token return tok構文エラーの報告タイミング

入力中に不正なトークンが見つかると、多くの場合、SLYは即座にエラーを処理する。このとき、SLYがエラー処理を、一つ以上の文法規則が還元されるまでの間、遅延させようとすることに注意せよ。"既定の状態"として知られる背後の構文解析表上の特殊な状態によって、この動作が予期しない結果を引き起こす可能性がある。既定の状態とは、次の入力にかかわらず同じ文法規則が還元される構文解析器の状態である。そのような状態下のSLYは、次の入力トークンを読まずに先に進むことを選択し、文法規則を還元する。継続するトークンが不正であれば、SLYはそれを読み込もうとし、構文エラーを報告する。こうした文法エラーに先立って文法規則が実行される動作仕様は、変わったものに見えるかもしれない。

エラー処理についての一般論

通常の言語において、エラー規則と再同期文字によるエラーからの復旧は、最も信頼性の高い手法である。文法でエラーを拾えるようになり、比較的容易に復旧し、構文解析処理を継続できる。パニックモード回復処理は、入力テキストからごっそり内容をそぎ落とし、再開のための道を歩ませたい、といったある種特別なアプリケーションでのみ役立つ。

行番号と位置情報の追跡

位置情報の追跡は、コンパイラーの作成時にしばしば厄介な問題となる。規定動作では、SLYはどのあらゆるトークンの行番号や位置情報を追跡する。生成規則内で、以下の属性が役に立つ。

p.lineno生成規則中の左端にある終端記号の行番号。p.index生成規則の左端にある終端記号の字句解析インデックス。例)

@_('expr PLUS expr') def expr(self, p): line = p.lineno # line number of the PLUS token index = p.index # Index of the PLUS token in input textSLYは、非終端記号に対して行番号を伝搬しない。これを行なう必要がある場合、自身で行番号を格納し、ASTノード内で他のデータ構造にそれを伝搬させる必要がある。

AST(抽象構文木)の生成

SLYは抽象構文木の生成に関する特殊函数を提供しない。とはいえ、そうした構築処理は自前で簡単に実施できる。

木構造生成の簡易手法として、個々の文法規則函数でタプルやリストを生成し、伝搬させる方法がある。様々な実現方法があるが、そのうちの一つを示す。

@_('expr PLUS expr', 'expr MINUS expr', 'expr TIMES expr', 'expr DIVIDE expr') def expr(self, p): return ('binary-expression', p[1], p.expr0, p.expr1) @_('LPAREN expr RPAREN') def expr(self, p): return ('group-expression',p.expr]) @_('NUMBER') def expr(self, p): return ('number-expression', p.NUMBER)他にも、抽象構文木ノードの種類に応じたデータ構造を作り、規則の中で対応するノード型を生成する方法がある。

class Expr: pass class BinOp(Expr): def __init__(self, op, left, right) self.op = op self.left = left self.right = right class Number(Expr): def __init__(self, value): self.value = value @_('expr PLUS expr', 'expr MINUS expr', 'expr TIMES expr', 'expr DIVIDE expr') def expr(self, p): return BinOp(p[1], p.expr0, p.expr1) @_('LPAREN expr RPAREN') def expr(self, p): return p.expr @_('NUMBER') def expr(self, p): return Number(p.NUMBER)この手法の利点は、より複雑な意味情報や型チェック、コード生成機能、ノードクラスのためのその他機能を付与できることにある。

開始記号の変更

通常、構文解析クラスに最初に現れる規則が、文法規則の開始規則(最上位規則)となる。これを変更するには、クラスに

start指定を追加する。例:class CalcParser(Parser): start = 'foo' @_('A B') def bar(self, p): ... @_('bar X') def foo(self, p): # Parsing starts here (start symbol above) ...

start指定は、巨大な文法の一部分のデバッグ処理で役に立つ。埋め込み動作

SLYが使用する構文解析手法は、動作は規則の終了時に実行される。以下のような規則があると仮定する。

@_('A B C D') def foo(self, p): print("Parsed a foo", p.A, p.B, p.C, p.D)この例では、提供された動作コードは、記号

A、B、C、Dのすべてが構文解析がされた後に実行される。ときおり、ではあるが、構文解析の最中にで小さなコードの断片を実行させることが有効な場合がある。たとえば、Aが構文解析された直後に、いくつかの動作を実行させたい場合があるとする。このためには、空規則を作成する。@_('A seen_A B C D') def foo(self, p): print("Parsed a foo", p.A, p.B, p.C, p.D) print("seen_A returned", p.seen_A]) @_('') def seen_A(self, p): print("Saw an A = ", p[-1]) # Access grammar symbol to the left return 'some_value' # Assign value to seen_Aこの例では

Aが構文解析スタックに移動された直後に空のseen_A規則が実行される。この規則の中でp[-1]は、スタック上にあるseen_A記号のすぐ左隣の記号を参照する。 上記のfoo規則では、Aの値となる。他の規則と同様に、埋め込み動作が値を返すことで、値が返却される。埋め込み動作の使用は、希に余計な移動/還元衝突を引き起こす。たとえば、衝突を起こさない文法があるとする。

@_('abcd', 'abcx') def foo(self, p): pass @_('A B C D') def abcd(self, p): pass @_('A B C X') def abcx(self, p): passここで、規則の一つに埋め込み動作を挿入したとする。

@_('abcd', 'abcx') def foo(self, p): pass @_('A B C D') def abcd(self, p): pass @_('A B seen_AB C X') def abcx(self, p): pass @_('') def seen_AB(self, p): passこれにより余計な移動/還元衝突が差し込まれる。この衝突は、

abcd規則とabcx規則の双方で同じ記号Cが隣に出現する、という事実によって引き起こされる。構文解析器は記号の移動(abcd規則)と、規則seen_AB(abcx規則)の還元のどちらを実行しても良い。埋め込み規則の一般的な使用法は、ローカル変数のスコープなど、構文解析の別の側面から制御を行なうことである。たとえばCのコードの構文解析をするなら、以下のようなコードを記述する。

@_('LBRACE new_scope statements RBRACE') def statements(self, p): # Action code ... pop_scope() # Return to previous scope @_('') def new_scope(self, p): # Create a new scope for local variables create_scope() ...この例の

new_scopeはLBRACE({)記号が構文解析された直後に実行される。これが、内部の記号表と構文解析器とは別の側面の挙動を修正する。規則statementsが完了すると、コードが埋め込み動作で行なわれた操作(pop_scope()など)を元に戻す。

- 投稿日:2021-01-10T18:18:42+09:00

機械学習の定番「サポートベクターマシン(SVM)」を高校生でもわかるよう解説

はじめに

機械学習の定番アルゴリズムの1つである「サポートベクターマシン(SVM)」ですが、

実用的、かつ比較的シンプルなアルゴリズムから、入門書等でも取り上げられることが多いです。ただし、解説の抜け漏れや、難解すぎる書籍や記事が多いと感じたので、備忘録も兼ねて

・網羅的

・平易な説明

・実データでの実装例あり(Pythonのライブラリscikit-learnを使用)を心がけ、高校生でも「理解した!」と言えるような記事を目指したいと思います。

注意

その1

・高校生でもわかると銘打ってしまったのに申し訳ありませんが、

高校で勉強しない(理系の大学1~2年で学習)偏微分の知識が出てきます。大変分かりやすいYouTube動画があるので、こちらを見れば「理解した!」と言えるのではと思います。

偏微分

ラグランジュの未定乗数法

不等式条件のラグランジュの未定乗数法(KKT条件)その2

・本文中の数式に

$${W^T}X$$

のように"T"という記号が出てきますが、これは行列の縦横を交換する「転置」です。

一見難解に見えますが、ベクトルの内積を行列の積で表現するための慣用的な表現で、

上式の場合ベクトルWとXの内積と読み替えれば問題ありません。その3

・アルゴリズムの最後に出てくる2次計画問題に関しては、私もソルバー頼みで解法を理解しているわけではないので、説明を省略することをご了承いただければと思います。

機械学習におけるサポートベクターマシンの位置づけ

サポートベクターマシンは、主に「分類」に使用されるアルゴリズムとなります。

・分類の例

ケース1:体温、せきの回数から、病気の有無を推定する

ケース2:長さ、重さ、色から果物の種類(リンゴ、ミカン、ブドウ)を推定するケース1は「有り」か「無し」の2種類の分類しか存在しないので、2値分類と呼び、

ケース2は3種類以上の分類が存在するので、多値分類(多クラス分類)と呼びます多値分類とサポートベクターマシン

本記事では2値分類のアルゴリズムを解説していますが、2値分類のアルゴリズムを複数並べることで、他値分類にも対応できます。

詳細はこちらが参考になります回帰とサポートベクターマシン

本手法を回帰に応用した「サポートベクター回帰」と呼ばれる手法もありますが、分類と比べると利用頻度が低いため、本記事では割愛します。

サポートベクターマシンの基本概念

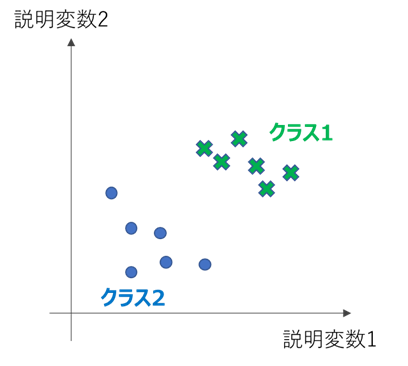

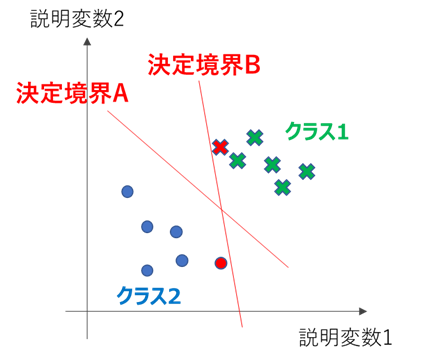

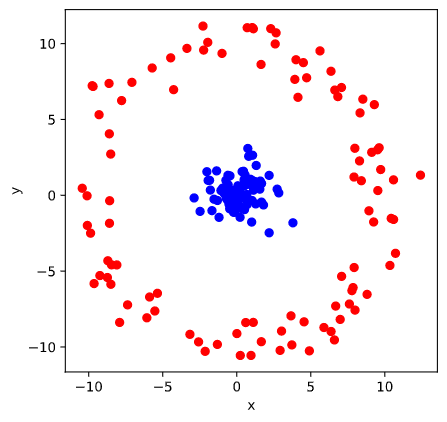

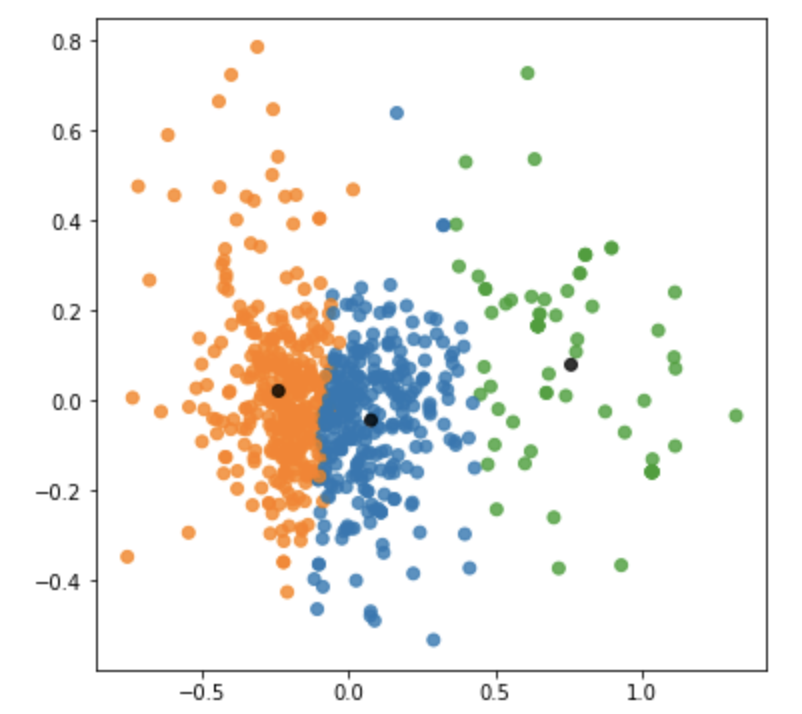

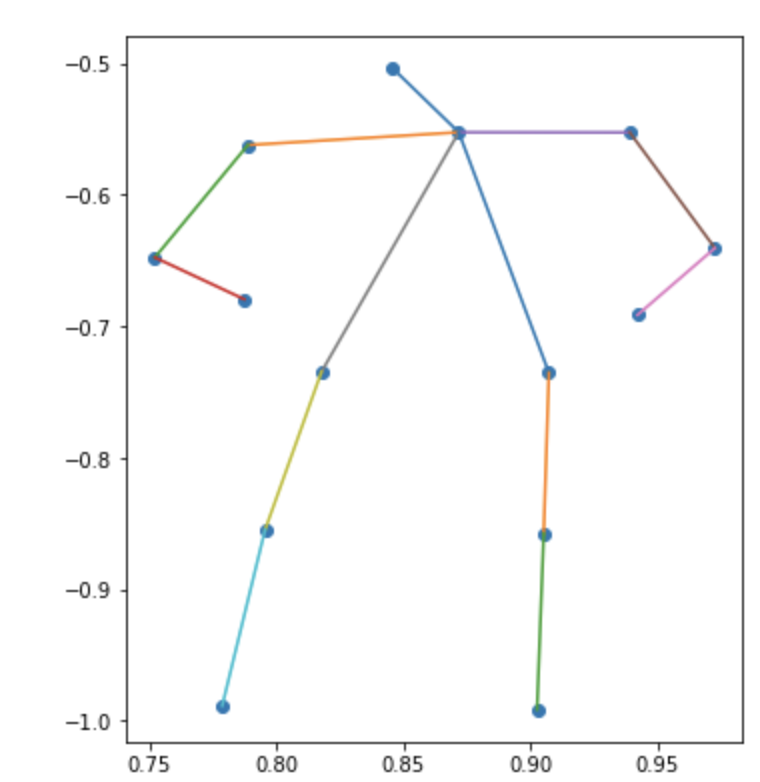

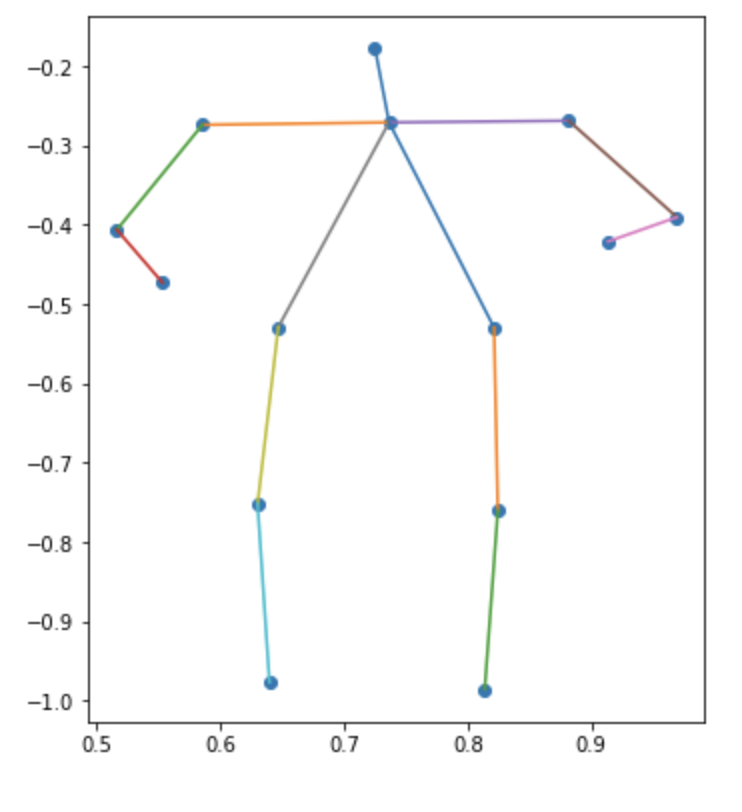

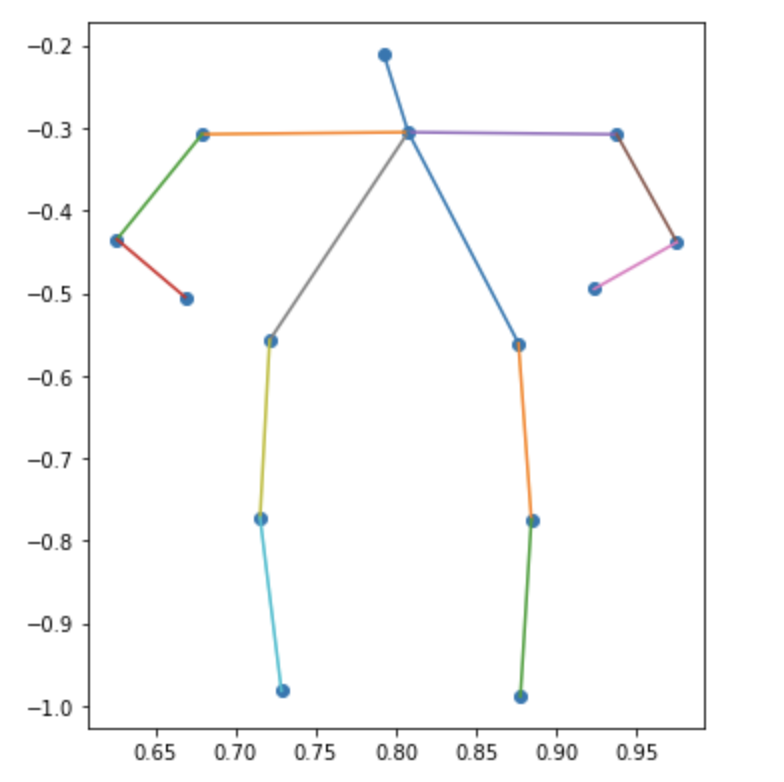

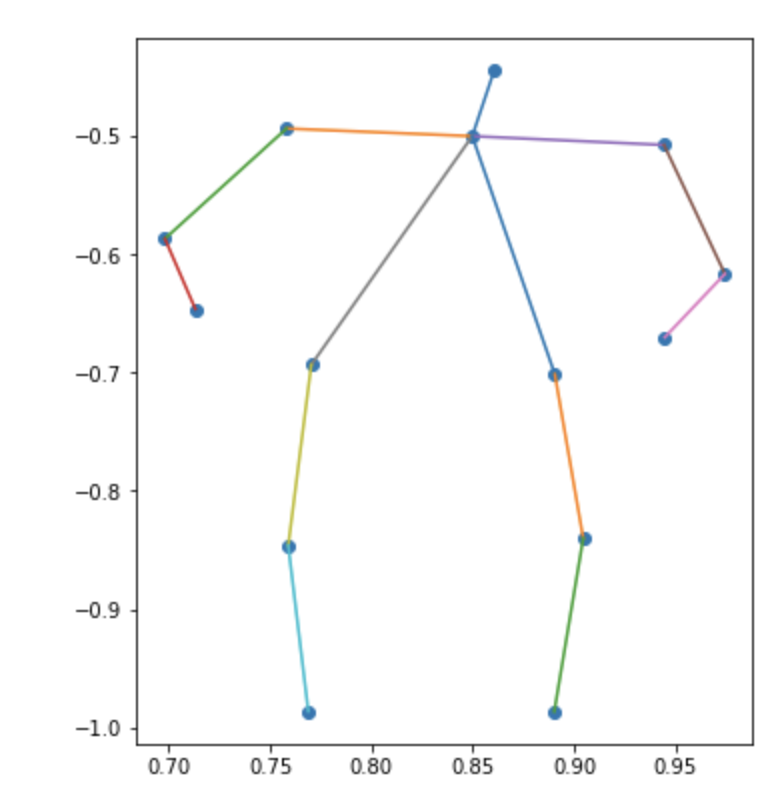

例えば下図のような2つの説明変数(例:体温、せきの回数)を使って、

クラス1(例:病気あり)とクラス2(例:病気なし)を分類したいとします。

機械学習の分類問題においては、これらのクラス間に境目となる直線や曲線(3次元以上では面)を引くことで、分類を実現します。

この境目となる直線や曲線を、決定境界と言います。上の例において直線で決定境界を引いた場合を考えます。

下図の決定境界Aと決定境界Bではどちらが分類性能が高く見えるでしょうか?

多くの人が、決定境界Aの方が高性能だと感じるかと思います。

そして決定境界Bが良くないと思う根拠として、

「赤く塗りつぶした点までの距離が近すぎて、誤判定しそう」

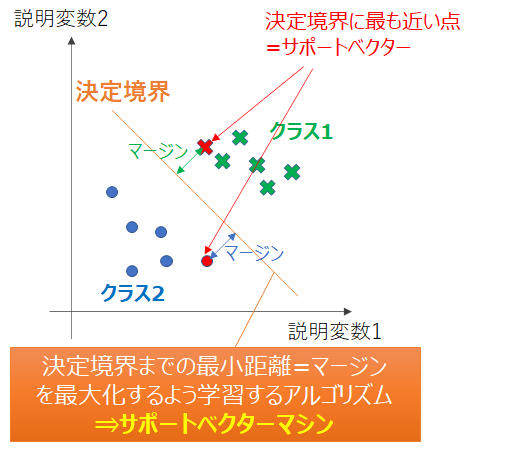

が、感覚的に違和感のない説明になるかと思います。「最も近い点(サポートベクター)までの距離が遠くなるよう決定境界を決める」分類手法を、

サポートベクターマシンと呼びます。例えば、2次元において直線の方程式は

ax + by + c = 0となります。

このとき、点(xi, yi)と直線の距離は\frac{|ax_i+by_i+c|}{\sqrt{a^2+b^2}}となるので、全ての学習データ(i=1,2,‥n)に対して

min_{i=1,2‥n}\frac{|ax_i+by_i+c|}{\sqrt{a^2+b^2}}を最大化するa, bの組合せを探す(cは規格化して消去される)ことが、2次元におけるサポートベクターマシンの学習となります。

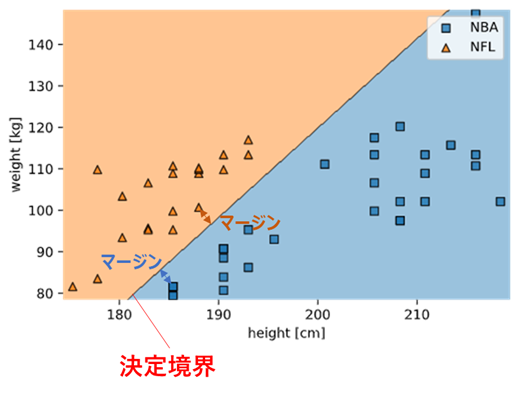

アルゴリズム詳細は次節で解説するので、まずは実データで実装してみましょう!

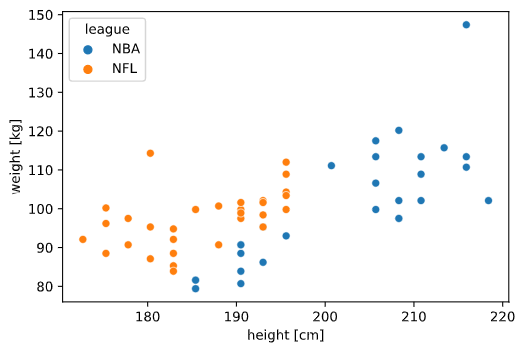

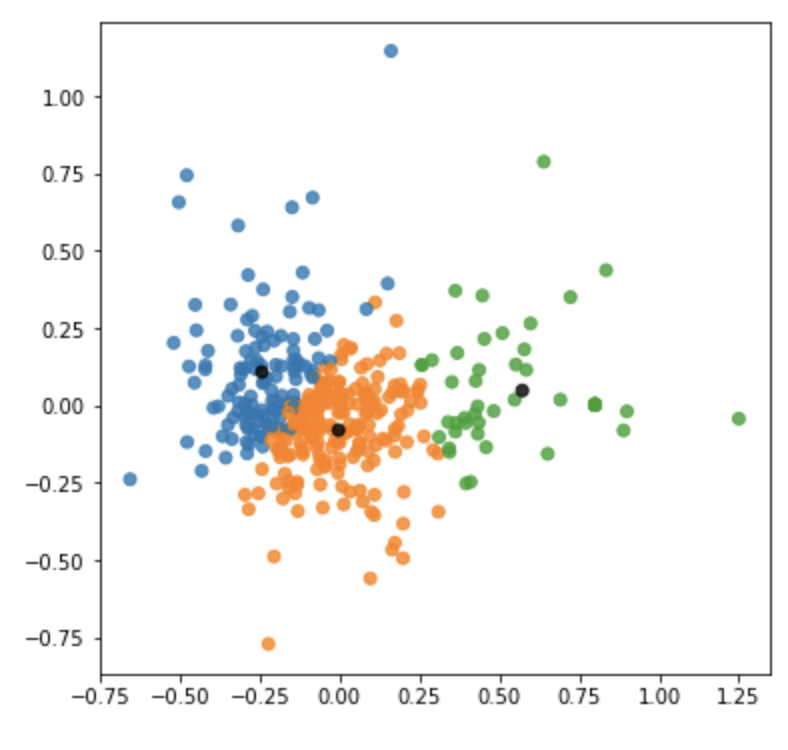

バスケットボール(NBA)選手とアメリカンフットボール(NFL)選手を身長体重で識別できるかを試してみますnba_nfl_1.csvname,league,position,height,weight Wilt Chambelain,NBA,C,215.9,113.4 Bill Russel,NBA,C,208.3,97.5 Kareem Abdul-Jabbar,NBA,C,218.4,102.1 Elvin Hayes,NBA,PF,205.7,106.6 Moses Malone,NBA,C,208.3,97.5 Tim Duncan,NBA,PF,210.8,113.4 Karl Malone,NBA,PF,205.7,117.5 Robert Parish,NBA,C,215.9,110.7 Kevin Garnett,NBA,PF,210.8,108.9 Nate Thurmond,NBA,C,210.8,102.1 Walt Bellamy,NBA,C,208.3,102.1 Wes Unseld,NBA,C,200.7,111.1 Hakeem Olajuwon,NBA,C,213.4,115.7 Dwight Howard,NBA,C,208.3,120.2 Shaquille O'Neal,NBA,C,215.9,147.4 John Stockton,NBA,PG,185.4,79.4 Jason Kidd,NBA,PG,193,95.3 Steve Nash,NBA,PG,190.5,80.7 Mark Jackson,NBA,PG,190.5,88.5 Magic Johnson,NBA,PG,205.7,99.8 Oscar Robertson,NBA,PG,195.6,93 Chris Paul,NBA,PG,185.4,79.4 LeBron James,NBA,SF,205.7,113.4 Isiah Thomas,NBA,PG,185.4,81.6 Gary Payton,NBA,PG,193,86.2 Andre Miller,NBA,PG,190.5,90.7 Rod Strickland,NBA,PG,190.5,83.9 Maurice Cheeks,NBA,PG,185.4,81.6 Russel Westbrook,NBA,PG,190.5,90.7 Rajon Rondo,NBA,PG,185.4,81.6 Ray Lewis,NFL,LB,185.4,108.9 London Fletcher,NFL,LB,177.8,109.8 Derrick Brooks,NFL,LB,182.9,106.6 Donnie Edwards,NFL,LB,188,100.7 Zack thomas,NFL,LB,180.3,103.4 Keith Brooking,NFL,LB,188,108.9 Karlos Dansby,NFL,LB,193,113.4 Junior Seau,NFL,LB,190.5,113.4 Brian Urlacher,NFL,LB,193,117 Ronde Barber,NFL,DB,177.8,83.5 Lawyer Milloy,NFL,DB,182.9,95.7 Takeo Spikes,NFL,LB,188,109.8 James Farrior,NFL,LB,188,110.2 Charles Woodson,NFL,DB,185.4,95.3 Antoine Bethea,NFL,DB,180.3,93.4 Derrick Johnson,NFL,LB,190.5,109.8 Lance Briggs,NFL,LB,185.4,110.7 Antoine Winfield,NFL,DB,175.3,81.6 Rodney Harrison,NFL,DB,185.4,99.8 Brian Dawkins,NFL,DB,182.9,95.3※NBA選手はポジションがばらけるようAssistsとReboundsの歴代15位までを、

NFL選手はTacklesの歴代20位まで(ディフェンスの選手)をデータベース化しています。縦軸を体重、横軸を身長としてプロットすると