- 投稿日:2020-11-16T23:32:49+09:00

googleapiclientを使うプログラムでPyInstallerするとエラーがでた話

問題

Google Api(スプレッドシート)を使うプログラムをPyInstallerで実行ファイル化しようとしたら,コンパイルはできたが実行時にエラーが発生.

コンパイルしたプログラムは以下のようなものmain.pyfrom googleapiclient.discovery import build # 以下略ここで,

pyinstaller --onefile main.py ./dist/main # コンパイルに成功し,実行ファイルができるさて,実行ファイルを実行すると,

pkg_resources.DistributionNotFound: The 'google-api-python-client' distribution was not found and is required by the application

解決方法

google-api-clientのバージョンを1.8.0にする.

要は以下を実行すれば良い.pip install google-api-python-client==1.8.0なんと画期的な解決方法でしょう!!!!

詳細

参考程度ですが,実行環境は

- OS: Raspbian GNU/Linux 10 (buster)

- Python: Python 3.7.3

おわりに

google-could-visionやFirestoreを使う場合類似したエラーについて書かれた記事を見かけたがあまり参考にならなかった.いずれの例でも

pkg_resources.DistributionNotFoundに遭遇しているため同様の解決方法で行けるかと思ったが全然できずに時間が溶けました.

結局,google-api-clientのgithubのissueの議論で解決した.

PyInstallerの代替としてcx_Freezeなどでも試してみたが結局できなかった.

この問題がいつまで発生(PyInstaller/Googleが対応するまで?)するか分かりませんし,いつまでこの方法で解決するかもわからないので参考程度にしてください.

PythonもGolangのように公式で(クロスプラットフォームな)実行ファイル化するような方法を確立してほしいと思いました.

- 投稿日:2020-11-16T22:24:27+09:00

総務省APIを使ってデータを取得する

総務省APIを使用してデータを取得

計量経済学のパネルデータを作成するためにPythonでデータをとってみました。(備忘録です)

準備

Python実行環境

総務省APIの取得

こちらからユーザ登録して取得できます。コード

def_TakeDataimport requests,urllib import pandas as pd import numpy as np import json def get_json(base_url,params): params_str=urllib.parse.urlencode(params) url=base_url+params_str json=requests.get(url).json() return json def take_data(dataid): appID="appIDを入れます" base_url="http://api.e-stat.go.jp/rest/2.1/app/json/getStatsData?" params={ "appId":appID, "lang":"J", "statsDataId":dataid, "metaGetFlg":"Y", "cntGetFlg":"N", "sectionHeaderFlg":"1" } data=get_json(base_url,params) return datatakedata=take_data(XXXXX)json形式のデータが変換されます

urlは

http://api.e-stat.go.jp/rest/2.1/app/getStatsData?appId=&lang=J&statsDataId=(ここにデータIDを入れる)&metaGetFlg=Y&cntGetFlg=N§ionHeaderFlg=1

上記の形式です。

総務省サイトから簡単にAPIリクエストURLを参照できます。json->DataFrame

例df=pd.DataFrame(data['GET_STATS_DATA']['STATISTICAL_DATA']['DATA_INF']['VALUE']) #jsonデータをpandasDataFrameに変換(例)欲しいデータをDataFrameに格納します。

-`data['GET_STATS_DATA']['STATISTICAL_DATA']['CLASS_INF']['CLASS_OBJ']`上記のコードでjsonにどのようなデータが入っているの確認できます。

これで操作しやすいDataFrameになりました

最後に

TwitterAPIとかよりは使いやすかったのでもっと詳しくかけるように頑張ります

Python初学者ですので間違いあれば指摘お願いいたします

- 投稿日:2020-11-16T21:59:33+09:00

pandas DataFrame で任意の値を含む行を削除

- 投稿日:2020-11-16T21:54:28+09:00

円周率の近似分数について

円周率

円周率。ただの定数であるがただの定数でない魅力と謎が詰まっている偉大な数です。

証明は簡単でないが一番馴染み深い無理数であり超越数なのではないのでしょうか?円周率の値

様々な方法で求められてきた歴史があります。今回の記事とはそこまで関係がないので具体的な方法を述べたりしませんが, 普通のノートpcでも現代のスペックであれば100桁くらいは簡単に(秒で)求めることができます。なぜそれで求められるか?の理論は普通に難しかったりしますが計算方法さえ認めてしまえば簡単です。

一応値を述べておきますが

π=3.141592653589 793238462643 383279502884 197169399375 105820974944 592307816406 286208998628 034825342117 067982148086 513282306647...と続いていきます。円周率の近似分数

今回の本題の近似分数とはなんぞや。という話です。厳密にやろうとすれば大学数学で勉強する実数の(有理数, 無理数の)稠密性なんかを考える必要がありますが直感的な説明だけで済ませますね。

まず円周率は無理数です。これも認めます。 完全にランダムかどうかはわかっていません。n桁目の数はランダムであるといわれています.

一方有理数は必ずどこがでループが出てきます. 1÷6=0.666...と6のループが出てきますし, 123÷999=0.123123123...と123のループが出てきます。

6÷2なんかも6÷2=3=2.999...と書くこともできるので割り切れたとしてもループが出てくるんですね.

ループの有り無しは有理数と無理数の大きな違いの一つです。

このように有理数無理数とは全然違う数なのですが, 円周率という無理数にいくらでも近い有理数を作ることはできます。 稠密なんて難しい言葉で言ったりするんですが, 雑に説明すると有理数の数列AnをA_1=3, \quad A_2=3.1, \quad A_3=3.14,\quad ...と定めればこの数列の極限は円周率と一致するんですね. 有理数しか現れないのに極限は無理数と同じといわれると変な感じが一瞬しますが, まあ直感的には納得できるのかなあと思います.

つまるところ, 円周率にいくらでも近い分数をつくれる. というわけです.

面白い事実

ここで以下のような問題を考えましょう

\text{集合$F_n$を以下のように定める.}\\ F_n:=\{\frac{a}{b}\mid 1 \leq a,b \leq 10^n-1,\quad a,b\in \mathbb{Z} \}とする.

このとき,F_n\text{の元で最も}\pi\text{に近いのは何だろう?}つまり

F_1\text{とは1÷1から9÷9までで作れる数の集合で} F_2\text{とは1÷1から99÷99までで作れる集合.}でありこのように分母分子の桁数に制限を与える中で最も円周率に近い分数とは何なのだろう?という問題です.

それをp(n)とでもしておきましょう.そして以下のような事実が知れれています。

\begin{align*} p(1)&=3/1\\ p(2)&=22/7\\ p(3)&=355/113\\ p(4)&=355/113=p(3) \end{align*}つまり355/113とはものすごく精度がよい近似値である!!というわけです!!

これは個人的にとても面白い事実です. だって分母分子4桁まで使ってもよいのに3桁÷3桁が精度の良い分数なんですから。

しかし, これは事実として知っているだけで「ほんまに?」と思ったわけですよ.ならプログラムの出番ですね.プログラムで総当たりで調べましょうプログラムを作る前の考察

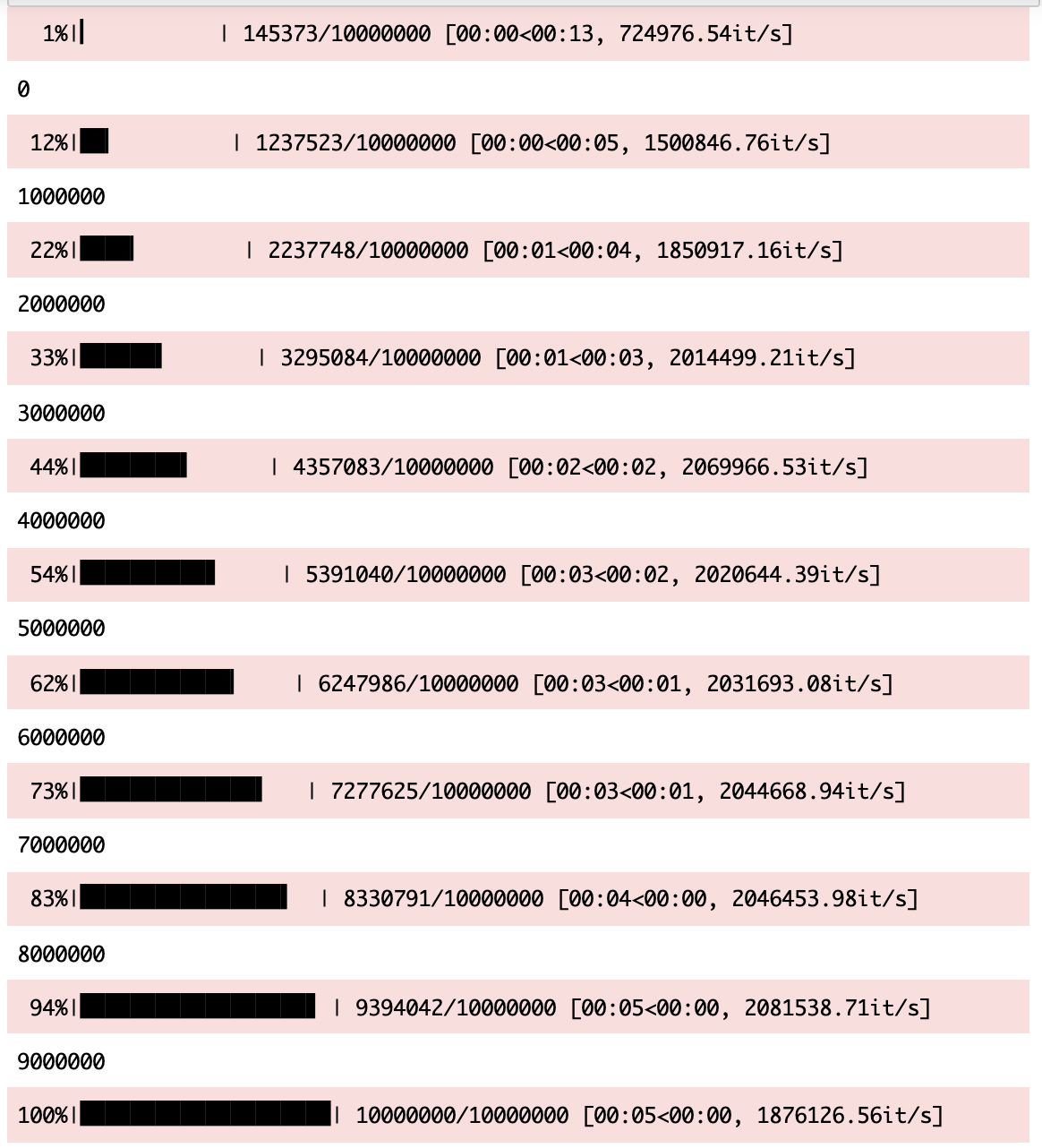

今回は4桁/4桁までを調べるので総当たりの計算量は10000*10000=10^8程度

このくらいなら総当たりでも調べられますが今後p(8)なんかも求めたくなるかもしれないので多少計算を省ける工夫をしてみましょう.工夫1:分子を分母*3から探索を始める

工夫2.途中で打ち切る動作を入れる

以上!多分これだけでも相当計算量減ると思うのでこれで実装していきます!プログラム

プログラムの実力が圧倒的に足りないので愚直に書いていきます.

pi=3.141592653589793#このくらいあれば十分かなあ n=int(input()) check=((10**n)-1)//3 ans=100 ans_list=[100,1] for i in range(1,check+1):#こっちが分母 for j in range(3*i,(10**n)): frac=j/i if abs(frac-pi)<abs(pi-ans): ans=frac ans_list=[j,i] else: if frac>ans: break print(ans) print(ans_list)実行結果

1 >>>3.0 >>>[3, 1] 2 >>>3.142857142857143 >>>[22, 7] 3 >>>3.1415929203539825 >>>[355, 113] 4 >>>3.1415929203539825 >>>[355, 113] 5 >>>3.1415926415926414 >>>[99733, 31746]本当に4桁÷4桁でも355/113が最強なんですね

ふざけたまとめ

355/113はすごい数字ですね. ちなみに僕のiPhoneの暗証番号昔355113でした.

まじめなまとめ

n=5あたりで相当遅いので改良してくださる方がいれば教えてもらえると幸いです.

追記

mathにmath.piなんてのあるんですね. ならこれでよろしいとおもいます.

import time import math n=int(input()) start=time.time() pi=math.pi check=((10**n)-1)//3 ans=100 ans_list=[100,1] for i in range(1,check+1):#こっちが分母 for j in range(int((pi)*i),(10**n)): frac=j/i if abs(frac-pi)<abs(pi-ans): ans=frac ans_list=[j,i] else: if frac>ans: break print(ans) print(ans_list) end=time.time() print(end-start)めちゃくちゃ早くなったのでp(8)まで求めてしましました

6 >>>3.141592653581078 >>>[833719, 265381] 7 >>>3.1415926535898153 >>>[5419351, 1725033] 8 >>>3.1415926535897927 >>>[80143857, 25510582]長年の謎が解けた気がして気持ちいです.

- 投稿日:2020-11-16T21:52:27+09:00

Ubuntu 20.04でSSL接続エラー(ssl.SSLError: [SSL: DH_KEY_TOO_SMALL])が発生する際の対処法

Ubuntu 20.04でPythonのサードパーティAPIを用いてSSL通信しようとしたところ以下のエラーが発生。Ubuntu 20.04で起こるらしい。

(Caused by SSLError(SSLError(1, '[SSL: DH_KEY_TOO_SMALL] dh key too small (_ssl.c:1123)')

下記のQAを参考に解決した方法をまとめます。

https://askubuntu.com/questions/1233186/ubuntu-20-04-how-to-set-lower-ssl-security-levelこのエラーが発生する背景

Debine系のOpenSSLのデフォルト設定がよりセキュアになったことが原因らしい。

セキュアになった背景はこれです。(英文です)

https://weakdh.org/簡単に概要を訳すとSSLで使用する鍵交換のアルゴリズムに脆弱性が見つかったため。

脆弱性に該当するSSL通信をしようとするとDH_KEY_TOO_SMALLのエラーが発生する。根本解決としてはサーバー側のセキュリティが改善されることだが、今回はサードパーティAPIを用いており不可能。

そのため暫定対処ではあるが、セキュリティレベルを変更する方法を採用した。openssl.cnfの編集してセキュリティレベルを変更

以下コマンドでopensslコンフィグファイルの配置ディレクトリを確認。

% openssl version -d

ちなみに一般的には"/usr/lib/ssl"配下にある。

ファイル冒頭に以下の1行を追記して保存。

openssl_conf = default_conf

次にファイル末尾に以下を追記する。

[ default_conf ]

ssl_conf = ssl_sect

[ssl_sect]

system_default = system_default_sect

[system_default_sect]

MinProtocol = TLSv1.2

CipherString = DEFAULT:@SECLEVEL=1これは何をしているかというとOpenSSLの暗号化のセキュリティレベルを下げている。

これだけでSSL通信できるようになるはず。openssl.cnfのローカル化

/usr/lib/ssl配下のコンフィグファイルを直接編集するとLinuxシステム全体に影響を与える。

影響を特定ユーザーでのログイン時等に局所化したい場合は以下を環境変数を.bashrcに追記する。export OPENSSL_CONF=/path/to/my/openssl.cnf

- 投稿日:2020-11-16T21:50:02+09:00

【検証】pytorchの最適化関数で点群の位置合わせをしてみる その1

はじめに

最近pytorchを覚えたので遊んでみます。

やることとしては、点群の位置合わせです。

目的としては、icpは局所解に陥りがちなイメージが個人的にはありますが、

pytorchの最先端な最適化関数なら結構いい線行くんじゃね?

というふわっとした期待の元やってみます。流れは以下の通りです。

for 点群Bの各ポイント 1.変換行列$P = [R|t]$を定義する。 このパラメータの最適化を行うことで位置合わせをする。 2.点群の最近傍を計算し、最も近いポイントの組を取得する。 3.変換行列$P$を適用した点群Bのポイントと、 点群Aの最近傍のポイント、この2つを損失関数で評価する。 4.最適化処理 最適化された変換行列$P$を適用してもう一度1から実行以下の流れで検証します。

1.同じ点群を2つ用意して、移動だけ行う(3次元のパラメータの調整) 2.同じ点群を2つ用意して、回転だけ行う(9次元のパラメータの調整) 3.同じ点群を2つ用意して、回転・移動行う(12次元のパラメータの調整) 3.異なる2つの点群を用意して、回転・移動行う(12次元のパラメータの調整) 3.他方にノイズを付与して異なる2つの点群を用意して、回転・移動行う(12次元のパラメータの調整)結果

・・・と、書きましたが1の段階で失敗しました。

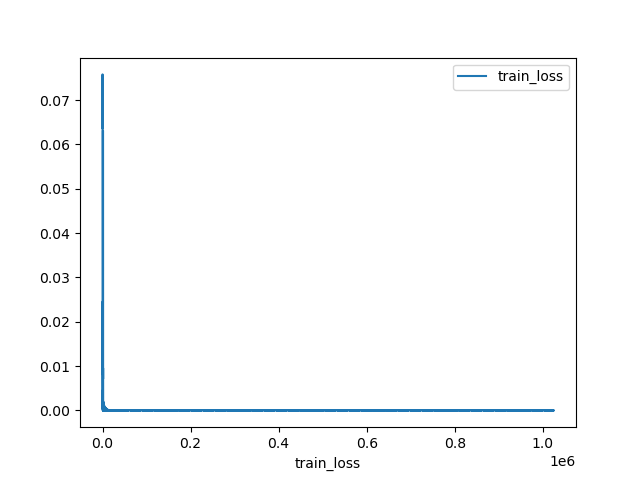

pytorchは未だ使い慣れていないので、何かが足りてないのかもしれません。tetst.pyimport copy import numpy as np import open3d as o3d import random import math import torch.nn as nn import torch.nn.functional as F import torch import torch.optim as optim import matplotlib.pyplot as plt epoch = 1000 def getPLYfromNumpy(nplist): pcd = o3d.geometry.PointCloud() pcd.points = o3d.utility.Vector3dVector(nplist) return pcd def write_point_cloud(path, pcl): assert o3d.io.write_point_cloud(path, pcl), "write pcl error : " + path def read_point_cloud(path): pcl = o3d.io.read_point_cloud(path) if len(pcl.points) == 0: assert False, "load pcl error : " + path return pcl def Register_EachPoint_RT(pclA, pclB,testP,criterion,optimizer): history = { 'train_loss': [], 'test_acc': [], } transP = torch.tensor( [[1.0, 0.0, 0.0, 0.0], [0.0, 1.0, 0.0, 0.0], [0.0, 0.0, 1.0, 0.0], [0.0, 0.0, 0.0, 1.0]], requires_grad=True) params = [transP] optimizer = optimizer(params) kd_tree_A = o3d.geometry.KDTreeFlann(pclA) cnt = 0 # ポイント単位でやってみる for j in range(epoch): for didx in range(len(pclB.points)): cnt += 1 optimizer.zero_grad() # 最近傍の計算 [_, Aidx1, _] = kd_tree_A.search_knn_vector_3d(pclB.points[didx], 1) ptA_sample = pclA.points[Aidx1[0]] ptB_sample = pclB.points[didx] # 同次座標 ptA_sample = np.array([ptA_sample[0], ptA_sample[1], ptA_sample[2], 1]) ptB_sample = np.array([ptB_sample[0], ptB_sample[1], ptB_sample[2], 1]) ptA_sample = ptA_sample.reshape(4, 1) ptB_sample = ptB_sample.reshape(4, 1) A_tor = torch.tensor(ptA_sample.tolist(), requires_grad=False) B_tor = torch.tensor(ptB_sample.tolist(), requires_grad=False) answer = A_tor output = torch.mm(transP, B_tor) loss = criterion(answer, output) loss.backward() optimizer.step() # print( j, cnt, " : 誤差 = ", loss.item(),"\n",transP) ls = np.linalg.norm(testP - transP.to('cpu').detach().numpy().copy()) history['train_loss'].append(loss) history['test_acc'].append(ls) print(" : 誤差 = ", loss.item(),"\t 正解の変換行列との誤差 = ",ls) plt.figure() plt.plot(range(1, cnt + 1), history['train_loss'], label='train_loss') plt.xlabel('train_loss') plt.legend() plt.savefig('train_loss.png') plt.figure() plt.plot(range(1, cnt + 1), history['test_acc'], label='test_acc') plt.xlabel('test_acc') plt.legend() plt.savefig('test_acc.png') return transP def Register_EachPoint_T(pclA, pclB,testP,criterion,optimizer): history = { 'train_loss': [], 'test_acc': [], } transP = torch.tensor([[0.0], [0.0], [0.0]],requires_grad=True) params = [transP] optimizer = optimizer(params) kd_tree_A = o3d.geometry.KDTreeFlann(pclA) cnt = 0 # ポイント単位でやってみる for j in range(epoch): for didx in range(len(pclB.points)): cnt += 1 optimizer.zero_grad() # 点群Bの各ポイントに対して最も近い点群Aのポイントを取得 [_, Aidx1, _] = kd_tree_A.search_knn_vector_3d(pclB.points[didx], 1) ptA_sample = pclA.points[Aidx1[0]] ptB_sample = pclB.points[didx] # 同次座標 ptA_sample = np.array([ptA_sample[0], ptA_sample[1], ptA_sample[2]]) ptB_sample = np.array([ptB_sample[0], ptB_sample[1], ptB_sample[2]]) ptA_sample = ptA_sample.reshape(3, 1) ptB_sample = ptB_sample.reshape(3, 1) # 各ポイントをTensor化 A_tor = torch.tensor(ptA_sample.tolist(), requires_grad=False) B_tor = torch.tensor(ptB_sample.tolist(), requires_grad=False) # 点群Bを調整して、点群Aに合わせていく。 answer = A_tor output = (B_tor + transP) # 損失計算 -> 最適化 loss = criterion(answer, output) loss.backward() optimizer.step() # 正解の変換行列との比較。(0が望ましい) ls = np.linalg.norm(testP - transP.to('cpu').detach().numpy().copy()) history['train_loss'].append(loss) history['test_acc'].append(ls) print(" : 誤差 = ", loss.item(), "\t 正解の変換行列との誤差 = ", ls) # 調整結果を反映 -> 次のループで再び最近傍計算 nptransP = transP.to('cpu').detach().numpy().copy().reshape(1,3) pclB = getPLYfromNumpy(pclB.points + nptransP) plt.figure() plt.plot(range(1, cnt + 1), history['train_loss'], label='train_loss') plt.xlabel('train_loss') plt.legend() plt.savefig('train_loss.png') plt.figure() plt.plot(range(1, cnt + 1), history['test_acc'], label='test_acc') plt.xlabel('test_acc') plt.legend() plt.savefig('test_acc.png') return transP POINT_NUM = 1024 # http://graphics.stanford.edu/data/3Dscanrep/ pclA = read_point_cloud("bun000.ply") A = np.array(pclA.points) A = np.array(random.sample(A.tolist(), POINT_NUM)) # 難易度が少し上の点群。たぶんこれはまだできない・・・ # pclB = read_point_cloud("bun045.ply") # B = np.array(pclB.points) # B = np.array(random.sample(B.tolist(), POINT_NUM)) # # ノイズ付与 # B += np.random.randn(POINT_NUM, 3) * 0.005 # # 点群のUnorder性(順番バラバラ)付与 # np.random.shuffle(B) # pclB_sample = getPLYfromNumpy(B) pclA_sample = getPLYfromNumpy(A) T_Projection = np.array([[1, 0, 0, 0.5], [0, 1, 0, 0], [0, 0, 1, 0], [0, 0, 0, 1]]) T_translation = np.array([[T_Projection[0][3]], [T_Projection[1][3]], [T_Projection[2][3]]]) pclA_trans_sample = getPLYfromNumpy(A).transform(T_Projection) write_point_cloud("A_before.ply", pclA_sample) write_point_cloud("A_rot_before.ply", pclA_trans_sample) def testEstimateT(pclA_sample,pclA_trans_sample,T_translation): optimizer = optim.Adam # MSELoss transP = Register_EachPoint_T(pclA_sample, pclA_trans_sample, T_translation, nn.MSELoss(),optimizer) T_res = np.array([[1, 0, 0, transP[0]], [0, 1, 0, transP[1]], [0, 0, 1, transP[2]], [0, 0, 0, 1]]) pclA_res = copy.copy(pclA_trans_sample) pclA_res = pclA_res.transform(T_res) write_point_cloud("TOnlytest_A_rot_after_MSELoss.ply", pclA_res) # # L1Loss # transP = Register_EachPoint_T(pclA_sample, pclA_trans_sample, T_translation, nn.L1Loss(),optimizer) # T_res = np.array([[1, 0, 0, transP[0]], # [0, 1, 0, transP[1]], # [0, 0, 1, transP[2]], # [0, 0, 0, 1]]) # pclA_res = copy.copy(pclA_trans_sample) # pclA_res = pclA_res.transform(T_res) # write_point_cloud("TOnlytest_A_rot_after_L1Loss.ply", pclA_res) def testEstimateRT(pclA_sample,pclA_trans_sample,T_Projection): optimizer = optim.Adam # MSELoss transP = Register_EachPoint_RT(pclA_sample, pclA_trans_sample, T_Projection, nn.MSELoss(),optimizer) transP = transP.to('cpu').detach().numpy().copy() pclA_res = copy.copy(pclA_trans_sample) pclA_res = pclA_res.transform(transP) write_point_cloud("RTtest_A_rot_after_MSELoss.ply", pclA_res) testEstimateT(pclA_sample, pclA_trans_sample, T_translation) # testEstimateRT(pclA_sample, pclA_trans_sample, T_Projection) exit()損失関数の出力結果を見てみます。

これだけ見ると、あっという間に0に収束してるように見えます。

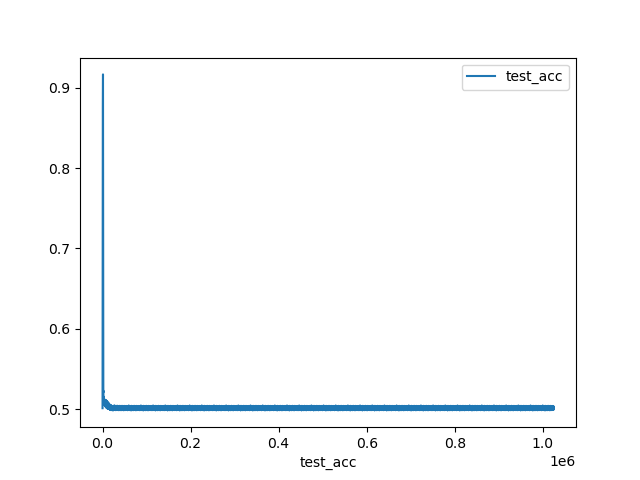

そして最適化により出力された変換行列と、正解の変換行列を比較したものがこれ。

・・・最初ちょっとだけ下がったかと思えば、あとはずっと腹ばいです。0.5と大きめの誤差です。

点群も出力しましたがわずかーーーーに近寄っただけだったので割愛します。まとめ

外れ値もなく3次元しかないのにどうしてぇ・・・という感じです。

pytorchの使い方を単純に間違えている気もします。

分かる方いたらぜひご連絡を。次はPointNetのT-netを拡張させたもの、PointNetLKについて勉強します。

https://github.com/wentaoyuan/it-net

https://www.slideshare.net/naoyachiba18/pointnetlk-robust-efficient-point-cloud-registration-using-pointnet-167874587

- 投稿日:2020-11-16T19:31:09+09:00

RXTE衛星PCA検出器でAGNの時間変動解析をgoogle Colabで簡単に行う方法

背景

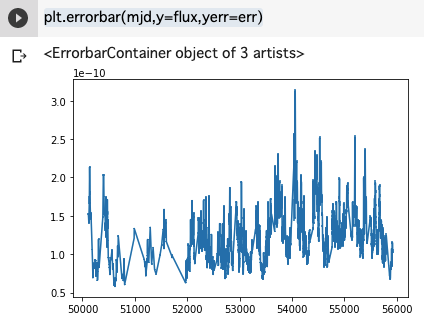

RXTE衛星のPCAという検出器によって取得された 2-10 keV のフラックスのデータを用いてプロットする方法を紹介する。

RXTEはASMという全天モニターの検出器もあるが、AGNのような暗い天体の場合(mCrabレベル)は、PCAのポインティング観測で得られたデータを使わないとまともなデータ解析ができない。

このような長期のデータは、サンプル時間が非一様で疎らであるが、その場合にえいやっと内挿してパワースペクトルを生成する方法も紹介する。スパースなデータの扱いはこれでは不十分であるが、quickにトレンドや傾向をみたい場合には知っておいてたら得するテクニックではある。

コードを読めばわかる人は、私の google Colab を参考ください。

3C273とは?

3C273 は、1959年に出版されたケンブリッジ電波源カタログ第3版の273番目に掲載された天体で、赤方偏移 z = 0.158 にあるクエーサーである。中心には太陽質量の8億倍ものブラックホールが存在しており、そこから強力なジェットが噴出していることが観測から確認されている。

ここでは、https://cass.ucsd.edu/~rxteagn/ の中から、

3C273という有名なブレーザーの長期の時間変動解析をgoogle Colab でやる方法を紹介する。にライトカーブのデータはある。

サンプルコード

データの取得とライトカーブのプロット

plot_3C273import urllib.request url="https://cass.ucsd.edu/~rxteagn/3C273/F0210_3C273" urllib.request.urlretrieve(url, '3C273.txt') import numpy as np mjd, flux, err, exp = np.loadtxt("3C273.txt", comments='#', unpack=True) import matplotlib.pyplot as plt plt.errorbar(mjd,y=flux,yerr=err)データの内挿

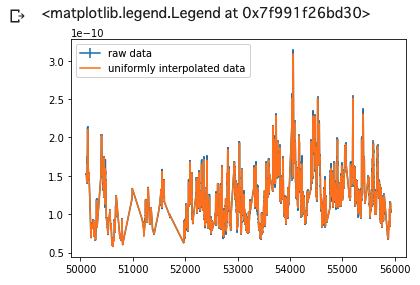

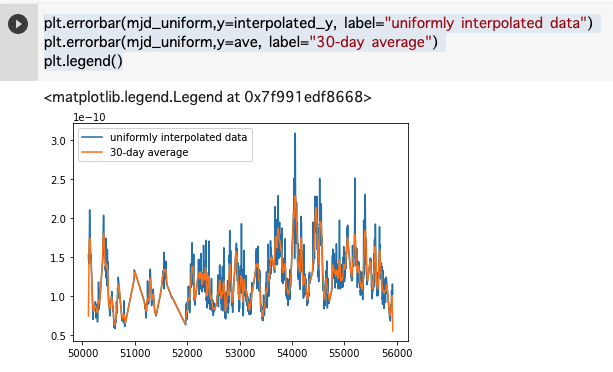

mjd_uniform=np.linspace(np.amin(mjd), np.amax(mjd), 6000) # 最初から最後までを6000等分する.6000という数字は適当だけど,1dayが一ビンになるくらい. interpolated_y = np.interp(mjd_uniform,mjd,flux) # スプライン補間をして,等間隔のデータを作る. plt.errorbar(mjd,y=flux,yerr=err, label="raw data") plt.errorbar(mjd_uniform,y=interpolated_y, label="uniformly interpolated data") plt.legend()numpyのinterpという関数で、スプライン補完して、等時間間隔のデータを生成する。

パワースペクトルの計算

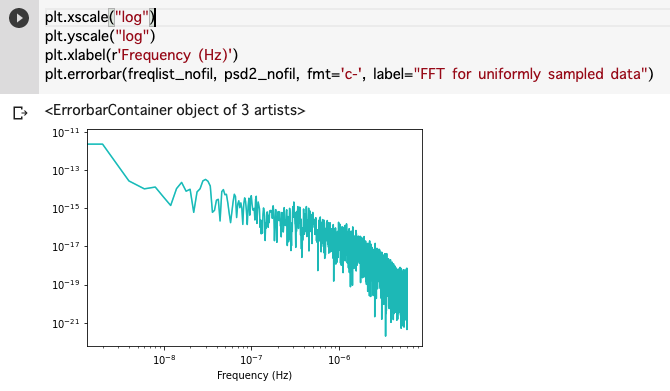

import matplotlib.mlab as mlab fNum=len(mjd_uniform) timebin=(mjd_uniform[1] - mjd_uniform[0]) * 24*60*60 # day to sec print("timebin = ", timebin, " fNum = ", fNum) psd2_nofil, freqlist_nofil = mlab.psd(interpolated_y,fNum,1./timebin, sides='onesided', scale_by_freq=True) plt.xscale("log") plt.yscale("log") plt.xlabel(r'Frequency (Hz)') plt.errorbar(freqlist_nofil, psd2_nofil, fmt='c-', label="FFT for uniformly sampled data")これでかなり強引であるが、低周波数までのパワースペクトルがかける。

移動平均を取る方法

# 30日の移動平均 # https://qiita.com/yamadasuzaku/items/fb744a207e7694d1598d ave = np.convolve(interpolated_y, np.ones(30)/float(30), 'same') plt.errorbar(mjd_uniform,y=interpolated_y, label="uniformly interpolated data") plt.errorbar(mjd_uniform,y=ave, label="30-day average") plt.legend()移動平均で高周波数成分を落とすには、numpyのconvolveを使うのがもっとも簡単にできる。

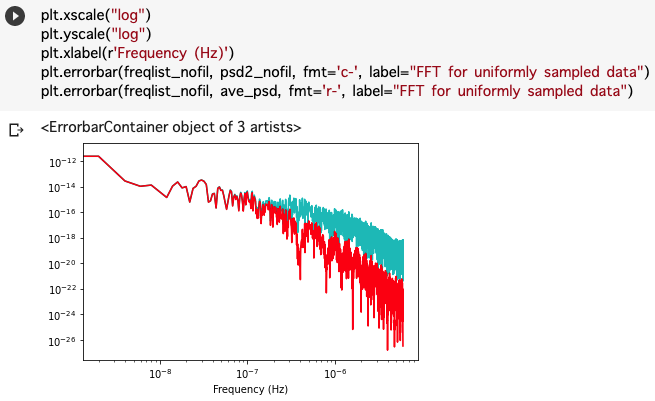

移動平均と取る前後でのパワースペクトルの比較

ave_psd, freq = mlab.psd(ave,fNum,1./timebin, sides='onesided', scale_by_freq=True) plt.xscale("log") plt.yscale("log") plt.xlabel(r'Frequency (Hz)') plt.errorbar(freqlist_nofil, psd2_nofil, fmt='c-', label="FFT for uniformly sampled data") plt.errorbar(freqlist_nofil, ave_psd, fmt='r-', label="FFT for uniformly sampled data")移動平均を取ることで高い周波数の成分が落ちていることが確認できる。

おまけ

これを利用すると、3C273の多波長の時系列データの相関なども簡単にとることができる。

データは手っ取り早くは、などに公開されている。

ただし、ここ紹介した補完は、台形補完で内挿して等間隔なデータを生成しているので、その近似が妥当かどうかはよく考えて使う必要がある。(とりあえずざっくりと相関をみる、というレベルでは問題ないので、実験データなどデータを手にしたらこれくらいはサッとやってみるのは大事かとは思う。)

- 投稿日:2020-11-16T19:06:32+09:00

[Blender×Python] ランダムをマスターしよう!!

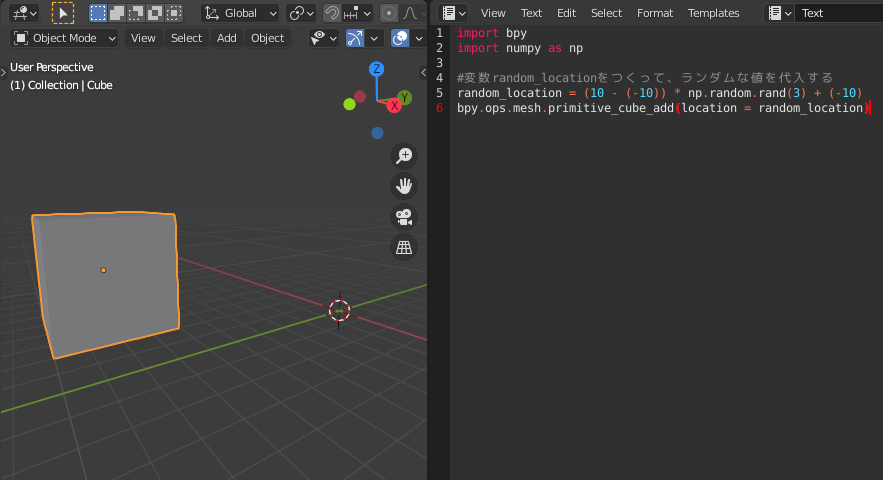

今回は、オブジェクトを大量に、かつランダムに配置する仕組みを紹介していきます。

目次

0.ランダムな数値を取得する方法

1.ランダムな位置に立方体を出現させる

2.関数をつくって処理をまとめる

3.サンプルコード

4.英単語

参考資料

0.ランダムな数値を取得する方法

今回は、numpyというライブラリ(便利なコードの集まり)の中の

rand()関数を使っていきます。rand()関数は、0から1までのランダムな値を返します。

引数(パラメータ)には、幾つのランダムな数値を返すかを指定します。

rand(3)ならば、ランダムな数値を3つ返します。import numpy as np #np.randomは右向きの矢印と考え無視して構いません。 np.random.rand(3)Point:import numpy as np

numpyというライブラリをコード中でnpという略称で表記するということ。array([0.90681482, 0.04813658, 0.47969033])↑

0から1の範囲のランダムな値が3つ出力されます。※arrayは配列という意味ですが、今回は気にしなくて大丈夫です。

数字が順番に入っている入れ物みたいなものです。1.ランダムな位置に立方体を出現させる

1-0.立方体をランダムな位置に出現させよう!!

数値計算のためのライブラリ

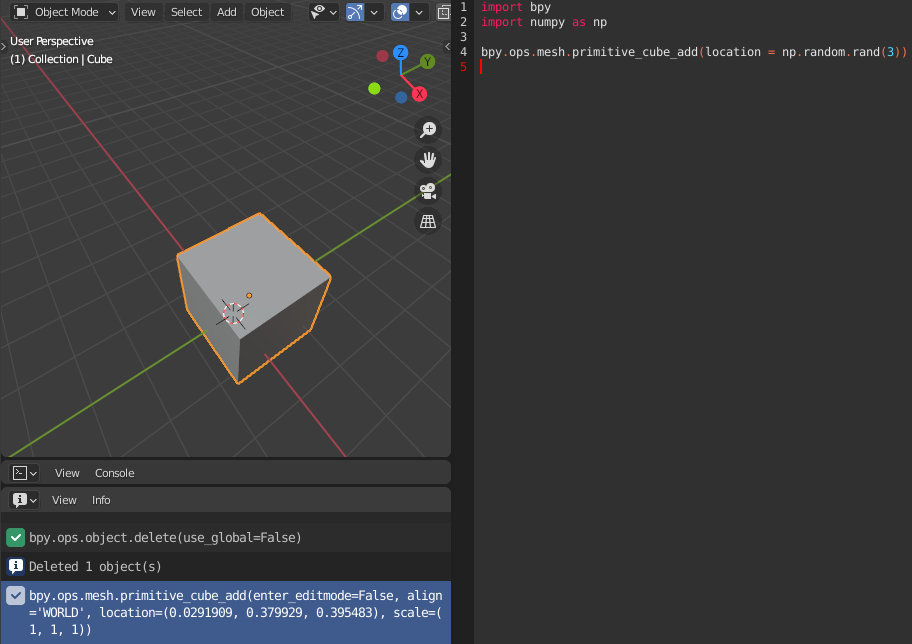

numpyを利用するimport bpy import numpy as np bpy.ops.mesh.primitive_cube_add(location = np.random.rand(3))Point:rand( )

0から1までのランダムな値を生成する。

引数で、値を何個返すのか決定する。rand(3)なら、ランダムな値を3つ返す。※写真では、変数locationに、3つのランダムな値→(0.0291909, 0.379929, 0.395483)が代入された。

1-1.立方体が出現する範囲を指定できるようにしよう

○-10以上10未満の範囲のランダムな数値を取得します。

コードは以下のような構造になっています。変数□にデータ(情報)を代入して、そのデータを使って処理を実行する。

そして、ドットは右向き矢印と考えてOK(ほぼ無視して良い).□ ← ランダムな数値データ ===> 関数( □ )import bpy import numpy as np #変数random_locationをつくって、ランダムな値を代入する random_location = (10 - (-10)) * np.random.rand(3) + (-10) bpy.ops.mesh.primitive_cube_add(location = random_location)Point:ある範囲内の数値

min以上max未満の範囲のランダムな値を取得する式は、

(max-min) * np.random.rand() + min

です。つまり、

数値が変動する範囲 * 0から1までのランダムな値 + 範囲のはじまり

ということです。今回の例で言うと、-10から、+20の範囲内の(ランダムな)数値を取得する。

範囲→(-10,..-9,..0,..9,..10)2.関数をつくって処理をまとめる

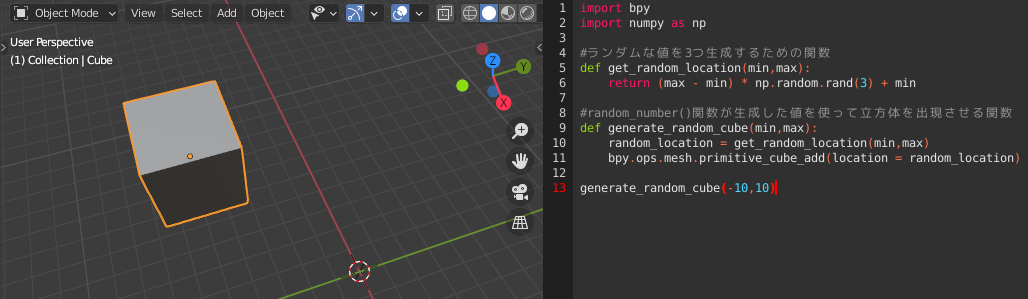

2-0.ランダムな数値を返す関数と、それを使って立方体を出現させる関数をつくる

import bpy import numpy as np #ランダムな値を3つ生成するための関数の定義 def get_random_location(min,max): return (max - min) * np.random.rand(3) + min #get_random_location()関数が生成した値を使って立方体を出現させる関数の定義 def generate_random_cube(min,max): random_location = get_random_location(min,max) bpy.ops.mesh.primitive_cube_add(location = random_location) generate_random_cube(-10,10)Point:Return

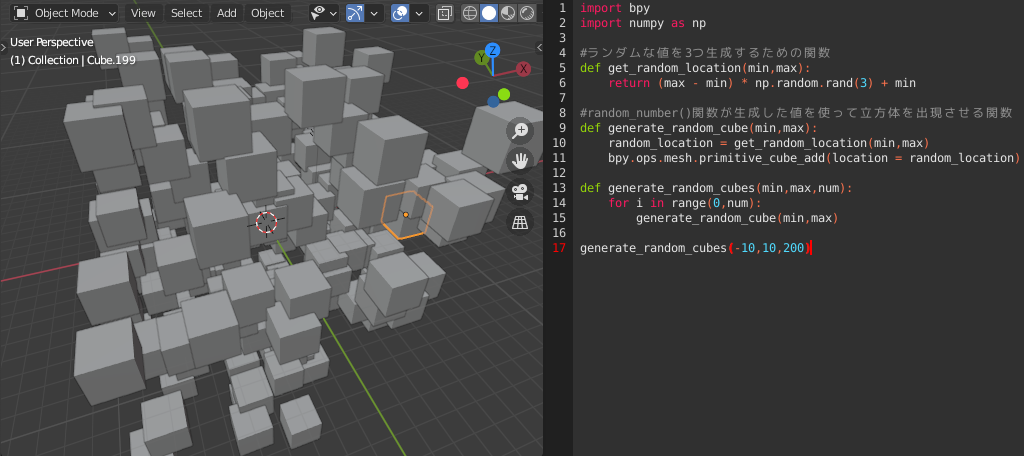

関数が何らかの情報を出力する時にreturn 情報という形で使います。2-1.複数の立方体をランダムな位置に出現させる関数をつくる

import bpy import numpy as np #ランダムな値を3つ生成するための関数の定義 def get_random_location(min,max): return (max - min) * np.random.rand(3) + min #get_random_location()関数が生成した値を使って立方体を出現させる関数の定義 def generate_random_cube(min,max): random_location = get_random_location(min,max) bpy.ops.mesh.primitive_cube_add(location = random_location) #複数の立方体をランダムな位置に出現させる関数の定義 def generate_random_cubes(min,max,num): for i in range(0,num): generate_random_cube(min,max) generate_random_cubes(-10,10,200)2-2.ランダムな位置にランダムな角度の立方体を複数出現させる

import bpy import math import numpy as np #ランダムな値を3つ生成するための関数の定義 def get_random_location(min,max): return (max - min) * np.random.rand(3) + min #random_number()関数が生成した値を使って立方体を回転、出現させる関数の定義 def generate_random_rotate_cube(min,max): random_location = get_random_location(min,max) bpy.ops.mesh.primitive_cube_add(location = random_location,rotation = math.pi * np.random.rand(3)) #複数の立方体をランダムな位置に回転、出現させる関数の定義 def generate_random_rotate_cubes(min,max,num): for i in range(0,num): generate_random_rotate_cube(min,max) generate_random_rotate_cubes(-10,10,200)

3.サンプルコード

色をランダムに決める関数をつくる

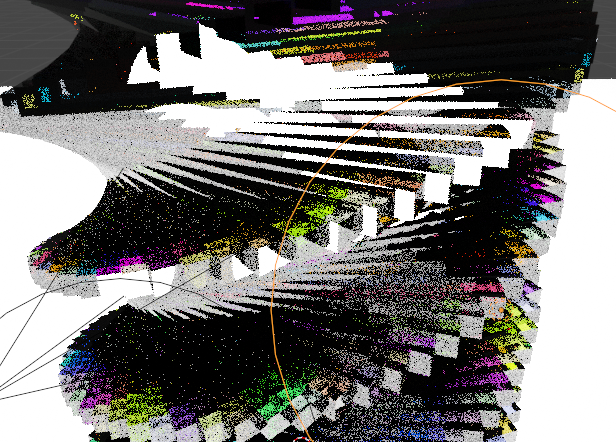

○カラフルな立方体をランダムな位置にランダムな角度で配置します。

import bpy import math import numpy as np #マテリアルを決める関数の定義 def material(name = 'material'): material_glass = bpy.data.materials.new(name) #ノードを使えるようにする material_glass.use_nodes = True p_BSDF = material_glass.node_tree.nodes["Principled BSDF"] #0→BaseColor/7→roughness(=粗さ)/15→transmission(=伝播) #default_value = (R, G, B, A) p_BSDF.inputs[0].default_value = np.random.rand(4) p_BSDF.inputs[7].default_value = 0 p_BSDF.inputs[15].default_value = 1 #オブジェクトにマテリアルの要素を追加する bpy.context.object.data.materials.append(material_glass) #ランダムな値を3つ生成するための関数の定義 def get_random_location(min,max): return (max - min) * np.random.rand(3) + min #random_number()関数が生成した値を使って立方体を回転、出現させる関数の定義 def generate_random_rotate_cube(min,max): random_location = get_random_location(min,max) bpy.ops.mesh.primitive_cube_add(location = random_location,rotation = math.pi * np.random.rand(3)) #複数の立方体をランダムな位置に回転、出現させる関数の定義 def generate_random_rotate_colorful_cubes(min,max,num): for i in range(0,num): generate_random_rotate_cube(min,max) material('Random') generate_random_rotate_colorful_cubes(-10,10,200)

立方体を回転させながら並べる関数をつくる

import bpy import math import numpy as np #マテリアルを決める関数の定義 def material(name = 'material'): material_glass = bpy.data.materials.new(name) #ノードを使えるようにする material_glass.use_nodes = True p_BSDF = material_glass.node_tree.nodes["Principled BSDF"] #0→BaseColor/7→roughness(=粗さ)/15→transmission(=伝播) #default_value = (R, G, B, A) p_BSDF.inputs[0].default_value = np.random.rand(4) p_BSDF.inputs[7].default_value = 0 p_BSDF.inputs[15].default_value = 1 #オブジェクトにマテリアルの要素を追加する bpy.context.object.data.materials.append(material_glass) #カラフルな立方体を回転させながら並べる関数の定義 def spiral_colorful_cubes(): #100回反復処理をする for i in range(0,100): bpy.ops.mesh.primitive_cube_add( #少しずつ上にずらす location=(0, 0, i/50), scale=(1, 1, 0.05), #180 * i * 36(度)ずつずらしていく rotation = (0, 0, math.pi*i*10/360) ) #オブジェクトにマテリアルの要素を追加する material('Random') #処理を実行する spiral_colorful_cubes()

トーラスを変形させて回転し、並べていく関数をつくる

import bpy import math import numpy as np #マテリアルを決める関数の定義 def material(name = 'material'): material_glass = bpy.data.materials.new(name) #ノードを使えるようにする material_glass.use_nodes = True p_BSDF = material_glass.node_tree.nodes["Principled BSDF"] #0→BaseColor/7→roughness(=粗さ)/15→transmission(=伝播) #default_value = (R, G, B, A) p_BSDF.inputs[0].default_value = np.random.rand(4) p_BSDF.inputs[7].default_value = 0 p_BSDF.inputs[15].default_value = 1 #オブジェクトにマテリアルの要素を追加する bpy.context.object.data.materials.append(material_glass) #トーラスを変形してずらしながら並べ、それぞれに色をつける関数の定義 def colorful_torus_spiral(): for i in range(0,36): bpy.ops.mesh.primitive_torus_add( location=(0, 0, 0), major_radius=1.0, minor_radius=0.01, ) #Y軸方向に縮める bpy.ops.transform.resize(value=(1, 0.3, 1)) #Z軸を中心に回転する bpy.ops.transform.rotate(value=math.pi*i*10/360,orient_axis='Z') #オブジェクトにマテリアルの要素を追加する material('Random') colorful_torus_spiral()

4.英単語

英単語 訳 spiral 螺旋 material 素材、材質 principled 原理、原則の primitive 原始的な math 数学 add 追加する context 文脈、環境 value 値 default 既定の append 追加する generate 生み出す inputs 取得する 参考資料

- 投稿日:2020-11-16T18:06:03+09:00

ツイッタートレンド解析のためのプログラム(個人的メモ)

こんにちは。自分は現在駒澤大学GMS学部の2年生でタイトルにあるようにツイッターのトレンドについて研究しています。この記事では研究やコードや参考になりそうなものを紹介します。

元々、ツイッタートレンドに興味があり、1年生の頃から、PythonとTwitterAPIとMeCabを使っていましたが、形態素解析して単語ごとに集計するという原始的なものでした。他に言語と位置情報や出現する漢字などで遊んでいました()

↓

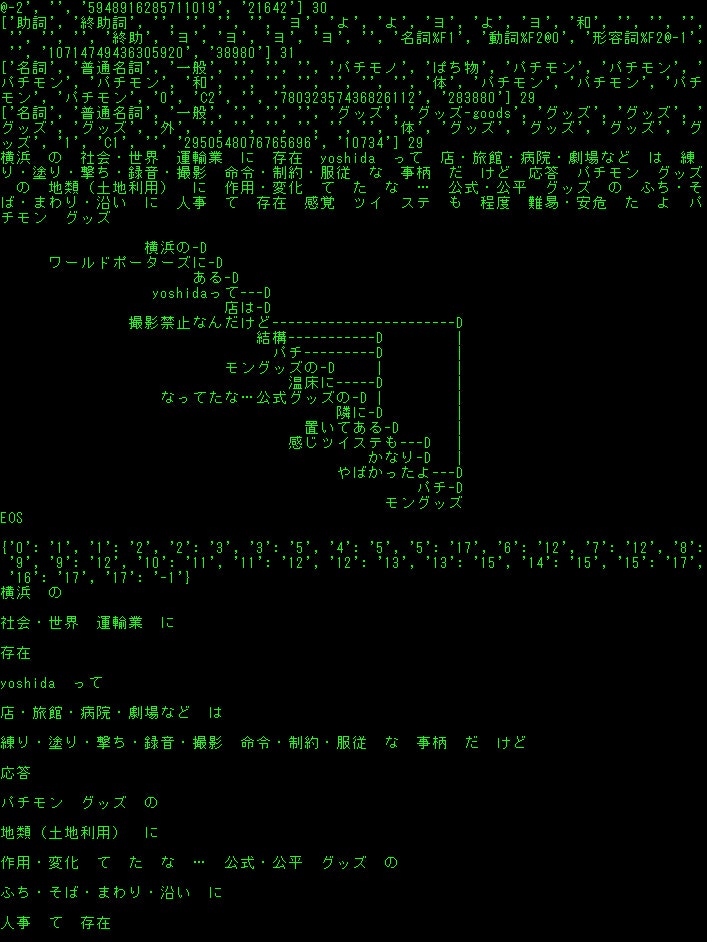

そしてN-gramの要領で例えば2-12単語節ごとに記録し、全てを集計する簡易的なトレンド解析ができました。補足として、単語節にはツイッターのトレンドにあるように助詞がどこにこないとか助動詞がどうとか、だいぶ手作業で規則を作りました。これが2年生最初の頃です

↓

その後、何を研究するかとなった時に、一日の中で変動する定常トレンドを定義してモデル化というアイデアもありましたが、それをして何になるのかとか自分でも思っていて、某大学の先生からもその点と規則に人の手が入っていることを指摘されました。2年生夏頃です

↓

少し彷徨っていましたが、https://pj.ninjal.ac.jp/corpus_center/goihyo.html

国立国語研究所のUnidic,分類語彙表,意味分類に辿り着き、単語の意味的正規化、クラスタリング?をしようとしました。なかなか良くできましたが、複数の辞書の対応表?逆引きの際に同音異義語のはずなのに意味が極端な方で参照されるだとかで、若干の人の手が入りましたが問題ではない程度だと思います。あと、Unidicには未知語もあり、そのトレンドが考慮されないという問題も。2年生の10月くらいですか

↓

意味の正規化ができたところで、係り受けを用いて意味の係り受けでトレンドを出したいというのは、前段の頃から思っていたため、CaboChaを使いました。これが面倒でゼミのサーバでもAWSでもできなかったので、苦労しながら自分のWindowsにインストールして、subprocessでバインディング?しました(Pythonは32bitしかないため)。UnidicとCabochaで(Cabochaも辞書指定できる?)区切る位置が違っていたので、最小公倍数的な要領で共通部分で合わせました

↓

結果、意味の係り受けに基づいた意味トレンド?は出せました。しかし、『同音異義語のはずなのに意味が極端な方で参照される』というので修正を加えたり、それこそ『キャンペーンで当たる!フォローしてツイート』とかいうのがあり、『簡易的なトレンド解析』では、表出トレンド?の重複を用いて削除する方法がありましたが、やはりそれを用いることにしました

↓

ここまで、『意味の係り受けに基づいた意味トレンド』と『簡易的表出トレンド』の解析ができていて、今思っているのは、意味トレンドというのは表出と違って分けるのが難しいというか深層心理とか大局的なものであって、この研究では具体的なものにすることが大事だと思っていて、

独立した?表出トレンドに付随する意味トレンドごとに集計するとか、意味トレンドから表出トレンドを推定するとか、どの程度両者を使い分けられるか、どう組み合わせるかというところが今後の課題で、今が2年生の11月で卒業研究に向けてまあ頑張っているところです。

一段落したので書きました。(もっと早くから書いておけばよかったかも)今更ですが表出トレンドというのは文字の羅列で、意味トレンドというのは文字を意味に置き換えた意味の羅列といった具合です。

もし使いたいとかなったら一言ツイッターでも、教えてくれるとありがたいです。そこが心配でした。著作権は自分にあるということにしてください。

バックアップ的な意味でも書きたいと思いました。

環境はWindows10-64bit Python3です(雑)

https://twitter.com/kenkensz9まず、表出トレンドを推定するためのプログラムです。

custam_freq_sentece.txtは解析のために取得した全テキスト

custam_freq_tue.txtはトレンド候補。

custam_freq.txtはトレンド。

custam_freq_new.txtはトレンドから重複したものを除いて最長トレンドを出したプログラムです。

また、トレンドは時間ごとに入れ替えています。

freshtime=int(time.time()*1000)-200000の部分。これはツイート取得の速度によって変えると良いです。

あと、そもそもツイートにこのワードが含まれていたら処理しない単語リストbadwordもあって、これはプログラムのバージョンで無いのもありますが管理がヘタなので、、お好みでどうぞ。hyousyutu_trend.py# coding: utf-8 import tweepy import datetime import re import itertools import collections from pytz import timezone import time import MeCab #import threading #from multiprocessing import Pool import os #import multiprocessing import concurrent.futures import urllib.parse #インポート import pdb; pdb.set_trace() import gc import sys import emoji consumer_key = "" consumer_secret = "" access_token = "" access_token_secret = "" auth = tweepy.OAuthHandler(consumer_key, consumer_secret) auth.set_access_token(access_token, access_token_secret) api = tweepy.API(auth) authapp = tweepy.AppAuthHandler(consumer_key,consumer_secret) apiapp = tweepy.API(authapp) #認証 m_owaka = MeCab.Tagger("-Owakati") m_ocha = MeCab.Tagger("-Ochasen") #mecab形態素分解定義 lang_dict="{'en': '英語', 'und': '不明', 'is': 'アイスランド語', 'ay': 'アイマラ語', 'ga': 'アイルランド語', 'az': 'アゼルバイジェン語', 'as': 'アッサム語', 'aa': 'アファル語', 'ab': 'アプハジア語', 'af': 'アフリカーンス語', 'am': 'アムハラ語', 'ar': 'アラビア語', 'sq': 'アルバニア語', 'hy': 'アルメニア語', 'it': 'イタリア語', 'yi': 'イディッシュ語', 'iu': 'イヌクティトット語', 'ik': 'イヌピア語', 'ia': 'インターリングア', 'ie': 'インターリング語', 'in': 'インドネシア語', 'ug': 'ウイグル語', 'cy': 'ウェールズ語', 'vo': 'ヴォラピュック語', 'wo': 'ウォロフ語', 'uk': 'ウクライナ語', 'uz': 'ウズベク語', 'ur': 'ウルドゥー語', 'et': 'エストニア語', 'eo': 'エスペラント語', 'or': 'オーリア語', 'oc': 'オキタン語', 'nl': 'オランダ語', 'om': 'オロモ語', 'kk': 'カザフ語', 'ks': 'カシミール語', 'ca': 'カタラン語', 'gl': 'ガリシア語', 'ko': '韓国語', 'kn': 'カンナダ語', 'km': 'カンボジア語', 'rw': 'キヤーワンダ語', 'el': 'ギリシャ語', 'ky': 'キルギス語', 'rn': 'キルンディ語', 'gn': 'グアラニー語', 'qu': 'クエチュア語', 'gu': 'グジャラト語', 'kl': 'グリーンランド語', 'ku': 'クルド語', 'ckb': '中央クルド語', 'hr': 'クロアチア語', 'gd': 'ゲーリック語', 'gv': 'ゲーリック語', 'xh': 'コーサ語', 'co': 'コルシカ語', 'sm': 'サモア語', 'sg': 'サングホ語', 'sa': 'サンスクリット語', 'ss': 'シスワティ語', 'jv': 'ジャワ語', 'ka': 'ジョージア語', 'sn': 'ショナ語', 'sd': 'シンド語', 'si': 'シンハラ語', 'sv': 'スウェーデン語', 'su': 'スーダン語', 'zu': 'ズールー語', 'es': 'スペイン語', 'sk': 'スロヴァキア語', 'sl': 'スロヴェニア語', 'sw': 'スワヒリ語', 'tn': 'セツワナ語', 'st': 'セト語', 'sr': 'セルビア語', 'sh': 'セルボクロアチア語', 'so': 'ソマリ語', 'th': 'タイ語', 'tl': 'タガログ語', 'tg': 'タジク語', 'tt': 'タタール語', 'ta': 'タミル語', 'cs': 'チェコ語', 'ti': 'チグリニャ語', 'bo': 'チベット語', 'zh': '中国語', 'ts': 'ヅォンガ語', 'te': 'テルグ語', 'da': 'デンマーク 語', 'de': 'ドイツ語', 'tw': 'トウィ語', 'tk': 'トルクメン語', 'tr': 'トルコ語', 'to': 'トンガ語', 'na': 'ナウル語', 'ja': '日本語', 'ne': 'ネパール語', 'no': 'ノルウェー語', 'ht': 'ハイチ語', 'ha': 'ハウサ語', 'be': '白ロシア語', 'ba': 'バシキール語', 'ps': 'パシト語', 'eu': 'バスク語', 'hu': 'ハンガリー語', 'pa': 'パンジャビ語', 'bi': 'ビスラマ語', 'bh': 'ビハール語', 'my': 'ビルマ語', 'hi': 'ヒンディー語', 'fj': 'フィジー語', 'fi': 'フィンランド語', 'dz': 'ブータン語', 'fo': 'フェロー語', 'fr': 'フランス語', 'fy': 'フリジア語', 'bg': 'ブルガリア語', 'br': 'ブルターニュ語', 'vi': 'ベトナム語', 'iw': 'ヘブライ語', 'fa': 'ペルシャ語', 'bn': 'ベンガル語', 'pl': 'ポーランド語', 'pt': 'ポルトガル語', 'mi': 'マオリ語', 'mk': 'マカドニア語', 'mg': 'マダガスカル語', 'mr': 'マラッタ語', 'ml': 'マラヤーラム語', 'mt': 'マルタ語', 'ms': 'マレー語', 'mo': 'モルダビア語', 'mn': 'モンゴル語', 'yo': 'ヨルバ語', 'lo': 'ラオタ語', 'la': 'ラテン語', 'lv': 'ラトビア語', 'lt': 'リトアニア語', 'ln': 'リンガラ語', 'li': 'リンブルク語', 'ro': 'ルーマニア語', 'rm': 'レートロマンス語', 'ru': 'ロシア語'}" lang_dict=eval(lang_dict) lang_dict_inv = {v:k for k, v in lang_dict.items()} #言語辞書 all=[] #リスト初期化 if os.path.exists('custam_freq_tue.txt'): alll=open("custam_freq_tue.txt","r",encoding="utf-8-sig") alll=alll.read() all=eval(alll) del alll #all=[] #書き出し用意 #freq_write=open("custam_freq.txt","w",encoding="utf-8-sig") sent_write=open("custam_freq_sentece.txt","a",encoding="utf-8-sig", errors='ignore') #書き出し用意 use_lang=["日本語"] use_type=["tweet"] #config uselang="" for k in use_lang: k_key=lang_dict_inv[k] uselang=uselang+" lang:"+k_key #config準備 def inita(f,k): suball=[] small=[] for s in k: if not int(f)==int(s[1]): #print("------",f) suball.append(small) small=[] #print(s[0],s[1]) small.append(s) f=s[1] suball.append(small) #2を含むなら return suball def notwo(al): micro=[] final=[] kaburilist=[] for fg in al: kaburilist=[] if len(fg)>1: for v in itertools.combinations(fg, 2): micro=[] for s in v: micro.append(s[0]) micro=sorted(micro,key=len,reverse=False) kaburi=len(set(micro[0]) & set(micro[1])) per=kaburi*100//len(micro[1]) #print(s[1],per,kaburi,len(micro[0]),len(micro[1]),"m",micro) if per>50: kaburilist.append(micro[0]) kaburilist.append(micro[1]) else: final.append([micro[0],s[1]]) #print("fin1",micro[0],s[1]) if micro[0] in micro[1]: pass #print(micro[0],micro[1]) #print("含まれます"*5) #if micro[0] in kaburilist: # kaburilist.remove(micro[0]) else: pass #print(fg[0][1],fg[0][0]) final.append([fg[0][0],fg[0][1]]) #print("fin3",fg[0][0],fg[0][1]) #if kaburilist: #longword=max(kaburilist,key=len) #final.append([longword,s[1]]) ##print("fin2",longword,s[1]) #kaburilist.remove(longword) #kaburilist=list(set(kaburilist)) #for k in kaburilist: # if k in final: # final.remove(k) # #print("finremove1",k) return final def siage(fin): fin=list(map(list, set(map(tuple, fin)))) finallen = sorted(fin, key=lambda x: len(x[0])) finallendic=dict(finallen) finalword=[] for f in finallen: finalword.append(f[0]) #print("f1",finalword) notwo=[] for v in itertools.combinations(finalword, 2): #print(v) if v[0] in v[1]: #print("in") if v[0] in finalword: finalword.remove(v[0]) #print("f2",finalword) finall=[] for f in finalword: finall.append([f,finallendic[f]]) finall = sorted(finall, key=lambda x: int(x[1]), reverse=True) #print("final",finall) kk=open("custam_freq_new.txt", 'w', errors='ignore') kk.write(str(finall)) kk.close() def eval_pattern(use_t): tw=0 rp=0 rt=0 if "tweet" in use_t: tw=1 if "retweet" in use_t: rt=1 if "reply" in use_t: rp=1 sword="" if tw==1: sword="filter:safe OR -filter:safe" if rp==0: sword=sword+" exclude:replies" if rt==0: sword=sword+" exclude:retweets" elif tw==0: if rp==1 and rt ==1: sword="filter:reply OR filter:retweets" elif rp==0 and rt ==0: print("NO") sys.exit() elif rt==1: sword="filter:retweets" elif rp==1: sword="filter:replies" return sword pat=eval_pattern(use_type)+" "+uselang #config読み込み関数と実行 def a(n): return n+1 def f(k): k = list(map(a, k)) return k def g(n,m): b=[] for _ in range(n): m=f(m) b.append(m) return b #連番リスト生成 def validate(text): if re.search(r'(.)\1{1,}', text): return False elif re.search(r'(..)\1{1,}', text): return False elif re.search(r'(...)\1{1,}', text): return False elif re.search(r'(...)\1{1,}', text): return False elif re.search(r'(....)\1{1,}', text): return False else: return True #重複を調べる関数 def eval_what_nosp(c,i): no_term=[] no_start=[] no_in=[] koyu_meisi=[] if re.findall(r"[「」、。)(『』&@_;【/<>,!】\/@]", c[0]): no_term.append(i) no_start.append(i) no_in.append(i) if len(c) == 4: if "接尾" in c[3]: no_start.append(i) if "固有名詞" in c[3]: koyu_meisi.append(i) if c[3]=="名詞-非自立-一般": no_term.append(i) no_start.append(i) no_in.append(i) if "助詞" in c[3]: no_term.append(i) no_start.append(i) #no_in.append(i) if c[3]=="助詞-連体化": no_start.append(i) if c[3]=="助詞": no_start.append(i) if "お" in c[2]: if c[3]=="名詞-サ変接続": no_term.append(i) no_start.append(i) no_in.append(i) if len(c) == 6: if c[4]=="サ変スル": no_start.append(i) if c[3]=="動詞-非自立": no_start.append(i) if "接尾" in c[3]: no_start.append(i) if c[3]=="助動詞": if c[2]=="た": no_start.append(i) no_in.append(i) if c[3]=="助動詞": if c[2]=="ない": no_start.append(i) if c[3]=="助動詞": if "連用" in c[5]: no_term.append(i) no_start.append(i) if c[2]=="する": if c[3]=="動詞-自立": if c[5]=="連用形": no_start.append(i) no_in.append(i) if c[2]=="なる": if c[3]=="動詞-自立": no_start.append(i) no_in.append(i) if c[2]=="てる": if c[3]=="動詞-非自立": no_start.append(i) no_in.append(i) if c[2]=="です": if c[3]=="助動詞": no_start.append(i) no_in.append(i) if c[2]=="ちゃう": if c[3]=="動詞-非自立": no_start.append(i) no_in.append(i) if c[2]=="ある": if c[3]=="動詞-自立": no_term.append(i) no_start.append(i) no_in.append(i) if c[2]=="助動詞": if c[3]=="特殊ダ": no_term.append(i) no_start.append(i) no_in.append(i) if c[2]=="ます": if c[3]=="助動詞": no_term.append(i) no_start.append(i) no_in.append(i) if "連用" in c[5]: no_term.append(i) if c[5]=="体言接続": no_start.append(i) if c[2]=="くれる": if c[3]=="動詞-非自立": no_start.append(i) no_in.append(i) x="" y="" z="" koyu="" if no_term: x=no_term[0] if no_start: y=no_start[0] if no_in: z=no_in[0] if koyu_meisi: koyu=koyu_meisi[0] #print("koyu",koyu) koyu=int(koyu) return x,y,z,koyu small=[] nodouble=[] seq="" def process(ty,tw,un,tagg): global all global seq global small global nodouble tw=tw.replace("\n"," ") sent_write.write(str(tw)) sent_write.write("\n") parselist=m_owaka.parse(tw) parsesplit=parselist.split() parseocha=m_ocha.parse(tw) l = [x.strip() for x in parseocha[0:len(parseocha)-5].split('\n')] nodouble=[] no_term=[] no_start=[] no_in=[] km_l=[] for i, block in enumerate(l): c=block.split('\t') #sent_write.write("\n") #sent_write.write(str(c)) #sent_write.write("\n") #print(str(c)) ha,hi,hu,km=eval_what_nosp(c,i) no_term.append(ha) no_start.append(hi) no_in.append(hu) km_l.append(km) #分かち 書き 完成 if km_l[0]: for r in km_l: strin=parsesplit[r] if not strin in nodouble: all.append([strin,un]) nodouble.append(strin) for s in range(2,8): #2から8の連鎖。 #重くする代わりに精度を上げられるので重要 num=g(len(parsesplit)-s+1,range(-1,s-1)) for nr in num: #1つの文章に対しての2-8連鎖の全通り #print(no_term) if not len(set(nr) & set(no_in)): if not nr[-1] in no_term: if not nr[0] in no_start: small=[] #print(str(parsesplit)) for nr2 in nr: #print(nr2,parsesplit[nr2]) #中の配列をインデックスとした位置にある単語をsmallに追加 small.append(parsesplit[nr2]) seq="".join(small) judge_whole=0 bad_direct_word=["みたいな","\'mat","I\'mat"] #if "" in seq: # judge_whole=1 #if "" in seq: # judge_whole=1 for bd in bad_direct_word: if seq==bd: judge_whole=1 break parselist=m_owaka.parse(seq) l = [x.strip() for x in parseocha[0:len(parseocha)-5].split('\n')] for n in range(len(l)): if len(l[n].split("\t"))==6: if l[n].split("\t")[3]=="動詞-自立": if len(l[n+1].split("\t"))==6: if l[n+1].split("\t")[3]: judge_whole=1 break if judge_whole==0: if validate(seq) and len(seq) > 3 and not re.findall(r'[「」、。『』/\\/@]', seq): if not seq in nodouble: #連続回避 all.append([seq,un]) nodouble.append(seq) #print("正常に追加",seq) #同じ単語を2度集計しない else: #print("既に含まれています",seq) pass else: #print("除外",seq) pass else: #print("始まりがno_startです",seq) pass else: #print("終わりがno_termです",seq) pass #print("\n") #print(parsesplit) #print(l) if tagg: print("tagg",tagg) for sta in tagg: all.append(["#"+str(sta),un]) #tagを含める N=1 #取得ツイート数 def print_varsize(): import types print("{}{: >15}{}{: >10}{}".format('|','Variable Name','|',' Size','|')) print(" -------------------------- ") for k, v in globals().items(): if hasattr(v, 'size') and not k.startswith('_') and not isinstance(v,types.ModuleType): print("{}{: >15}{}{: >10}{}".format('|',k,'|',str(v.size),'|')) elif hasattr(v, '__len__') and not k.startswith('_') and not isinstance(v,types.ModuleType): print("{}{: >15}{}{: >10}{}".format('|',k,'|',str(len(v)),'|')) def collect_count(): global all global deadline hh=[] tueall=[] #print("alllll",all) freshtime=int(time.time()*1000)-200000 deadline=-1 #import pdb; pdb.set_trace() #print(N_time) print(len(N_time)) for b in N_time: if int(b[1]) < freshtime: deadline=b[0] print("dead",deadline) dellist=[] if not deadline ==-1: for b in N_time: print("b",b) if int(b[0]) < int(deadline): dellist.append(b) for d in dellist: N_time.remove(d) #print(N_time) #import pdb; pdb.set_trace() #time.sleep(2) #import pdb; pdb.set_trace() for a in all: if int(a[1]) > freshtime: #取得したいツイート数/45*1000の値を引く。今は5000/45*1000=112000 tueall.append(a[0]) #print("tuealllappend"*10) #print(tueall) else: all.remove(a) #print("allremove",a) #import pdb; pdb.set_trace() c = collections.Counter(tueall) c=c.most_common() #print("c",c) #print(c) for r in c: if r and r[1]>1: hh.append([str(r[0]),str(r[1])]) k=str(hh).replace("[]","") freq_write=open("custam_freq.txt","w",encoding="utf-8-sig", errors='ignore') freq_write.write(str(k)) #import pdb; pdb.set_trace() oldunix=N_time[0][1] newunix=N_time[-1][1] dato=str(datetime.datetime.fromtimestamp(oldunix/1000)).replace(":","-") datn=str(datetime.datetime.fromtimestamp(newunix/1000)).replace(":","-") dato=dato.replace(" ","_") datn=datn.replace(" ","_") #print(dato,datn) #import pdb; pdb.set_trace() freq_writea=open("trenddata/custam_freq-"+dato+"-"+datn+"--"+str(len(N_time))+".txt","w",encoding="utf-8-sig", errors='ignore') freq_writea.write(str(k)) #import pdb; pdb.set_trace() freq_write_tue=open("custam_freq_tue.txt","w",encoding="utf-8-sig", errors='ignore') freq_write_tue.write(str(all)) #print(c) def remove_emoji(src_str): return ''.join(c for c in src_str if c not in emoji.UNICODE_EMOJI) def deEmojify(inputString): return inputString.encode('ascii', 'ignore').decode('ascii') def get_tag(tw,text_content): taglist=[] entities=eval(str(tw.entities))["hashtags"] for e in entities: text=e["text"] taglist.append(text) for _ in range(len(taglist)+2): for s in taglist: text_content=re.sub(s,"",text_content) #text_content=re.sub(r"#(.+?)+ ","",text_content) return taglist,text_content def get_time(id): two_raw=format(int(id),'016b').zfill(64) unixtime = int(two_raw[:-22],2) + 1288834974657 unixtime_th = datetime.datetime.fromtimestamp(unixtime/1000) tim = str(unixtime_th).replace(" ","_")[:-3] return tim,unixtime non_bmp_map = dict.fromkeys(range(0x10000, sys.maxunicode + 1), '') N_time=[] def gather(tweet,type,tweet_type,removed_text): global N global N_all global lagtime global all_time global all global auth global N_time if get_time(tweet.id): tim,unix=get_time(tweet.id) else: exit #細かいツイート時間を取得 #original_text=tweet.text nowtime=time.time() tweet_pertime=str(round(N/(nowtime-all_time),1)) lag=str(round(nowtime-unix/1000,1)) #ラグを計算 lang=lang_dict[tweet.lang] print(N_all,N,tweet_pertime,"/s","+"+lag,tim,type,tweet_type,lang) #情報表示。(全ツイート、処理ツイート、処理速度、ラグ、実時間、入手経路、ツイートタイプ、言語) print(removed_text.replace("\n"," ")) taglist,tag_removed_text=get_tag(tweet,removed_text) #import pdb; pdb.set_trace() #print(type(tweet)) #import pdb; pdb.set_trace() #タグを除く noemoji=remove_emoji(tag_removed_text) try: process(tweet_type,tag_removed_text,unix,taglist) N_time.append([N,unix]) print("trt",tag_removed_text) except Exception as pe: print("process error") print(pe) #import pdb; pdb.set_trace() #実処理に送る surplus=N%1000 if surplus==0: #sumprocess() try: collect_count() except Exception as eeee: print(eeee) #exit #集計しよう cft_read=open("custam_freq.txt","r",encoding="utf-8-sig") cft_read=cft_read.read() cft_read=eval(cft_read) max_freq=cft_read[0][1] #最大値 allen=inita(max_freq,cft_read) #同じ頻度のトレンドでまとめたリストにする。 finf=notwo(allen) #重複する文字列、重複するトレンドを探して削除する siage(finf) #それをnew_freqとして書き込む print_varsize() #メモリ情報を表示 N=N+1 #streaming本体 def judge_tweet_type(tweet): text = re.sub("https?://[\w/:%#\$&\?\(\)~\.=\+\-]+","",tweet.text) if tweet.in_reply_to_status_id_str : text=re.sub(r"@[a-zA-Z0-9_]* ","",text) text=re.sub(r"@[a-zA-Z0-9_]","",text) return "reply",text else: head= str(tweet.text).split(":") if len(head) >= 2 and "RT" in head[0]: text=re.sub(r"RT @[a-zA-Z0-9_]*: ","",text) return "retwe",text else: return "tweet",text badword=["質問箱","マシュマロを投げ合おう","質問がじゃんじゃん届く","参戦","配信","@","フォロー","応募","スマホRPG","ガチャ","S4live","キャンペーン","ドリフトスピリッツ","プレゼント","協力ライブ","完全無料で相談受付中","おみくじ","当たるチャンス","GET","ゲット","shindanmaker","当たる","抽選"] N_all=0 def gather_pre(tweet,type): global N_all N_all=N_all+1 #ここを通過する全ツイート数カウント go=0 for b in badword: if b in tweet.text: go=1 break #テキスト内にbadwordがあるか判断、0で含まれないからGO判断 if go == 0: if tweet.lang=="ja": tweet_type,removed_text=judge_tweet_type(tweet) #ツイートタイプを判断 if tweet_type=="tweet": try: gather(tweet,type,tweet_type,removed_text) #print(type(tweet)) #gather処理に送る。 except Exception as eee: #gather("あ","あ","あ","あ") #import pdb; pdb.set_trace() pass lagtime=0 def search(last_id): #print(pat) global pat time_search =time.time() for status in apiapp.search(q=pat,count="100",result_type="recent",since_id=last_id): #searchで最後に取得したツイートよりも新しいツイートを取得 gather_pre(status,"search") #search本体 interval = 2.16 #search呼び出し間隔 #min2 trysearch=0 #search呼び出し回数 class StreamingListener(tweepy.StreamListener): def on_status(self, status): global time_search global trysearch gather_pre(status,"stream") time_stream=time.time() time_stream-time_search % interval if time_stream-time_search-interval>interval*trysearch: #一定時間(interbal)ごとにsearchを実行する。 last_id=status.id #executor = concurrent.futures.ThreadPoolExecutor(max_workers=8) #executor.submit(search(last_id)) #並列処理を試す場合 search(last_id) trysearch=trysearch+1 #streaming本体 def carry(): listener = StreamingListener() streaming = tweepy.Stream(auth, listener) streaming.sample() #stream呼び出し関数 time_search =time.time() #searchを最後に実行した時間だがstream前に定義 executor = concurrent.futures.ThreadPoolExecutor(max_workers=8) #並列定義 all_time=time.time() #実行開始時間定義 try: carry() except Exception as e: import pdb; pdb.set_trace() print(e) #import pdb; pdb.set_trace() pass #except Exception as ee: #print(ee) #import pdb; pdb.set_trace() #carry本体とエラー処理下は意味トレンドのプログラムですが、絶賛作業中なので、自信をもってオススメできます()。シソーラスから持ってくる部分は自分が書いたものではないですが、残しておきます。

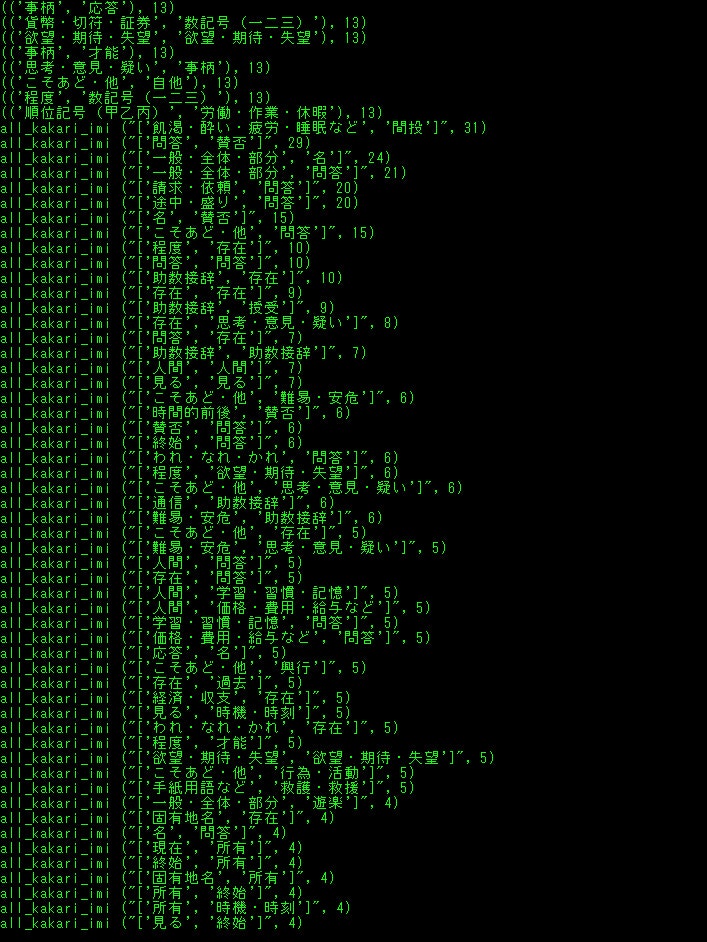

imi_trend.pyfrom bs4 import BeautifulSoup import collections import concurrent.futures import datetime import emoji import itertools import MeCab from nltk import Tree import os from pathlib import Path from pytz import timezone import re import spacy import subprocess import sys import time import tweepy import unidic2ud import unidic2ud.cabocha as CaboCha from urllib.error import HTTPError, URLError from urllib.parse import quote_plus from urllib.request import urlopen m=MeCab.Tagger("-d ./unidic-cwj-2.3.0") os.remove("bunrui01.csv") os.remove("all_tweet_text.txt") os.remove("all_kakari_imi.txt") bunrui01open=open("bunrui01.csv","a",encoding="utf-8") textopen=open("all_tweet_text.txt","a",encoding="utf-8") akiopen=open("all_kakari_imi.txt","a",encoding="utf-8") catedic={} with open('categori.txt') as f: a=f.read() aa=a.split("\n") b=[] bunrui01open.write(",,,") for i, j in enumerate(aa): catedic[j]=i bunrui01open.write(str(j)) bunrui01open.write(",") bunrui01open.write("\n") print(catedic) with open('./BunruiNo_LemmaID_ansi_user.csv') as f: a=f.read() aa=a.split(",\n") b=[] for bb in aa: if len(bb.split(","))==2: b.append(bb.split(",")) word_origin_num_to_cate=dict(b) with open('./cate_rank2.csv') as f: a=f.read() aa=a.split("\n") b=[] for bb in aa: if len(bb.split(","))==2: b.append(bb.split(",")) cate_rank=dict(b) class Synonym: def getSy(self, word, target_url, css_selector): try: # アクセスするURLに日本語が含まれているのでエンコード self.__url = target_url + quote_plus(word, encoding='utf-8') # アクセスしてパース self.__html = urlopen(self.__url) self.__soup = BeautifulSoup(self.__html, "lxml") result = self.__soup.select_one(css_selector).text return result except HTTPError as e: print(e.reason) except URLError as e: print(e.reason) sy = Synonym() alist = ["選考"] # 検索する先は「日本語シソーラス 連想類語辞典」を使用 target = "https://renso-ruigo.com/word/" selector = "#content > div.word_t_field > div" #for item in alist: # print(sy.getSy(item, target, selector)) consumer_key = "" consumer_secret = "" access_token = "" access_token_secret = "" auth = tweepy.OAuthHandler(consumer_key, consumer_secret) auth.set_access_token(access_token, access_token_secret) api = tweepy.API(auth) authapp = tweepy.AppAuthHandler(consumer_key,consumer_secret) apiapp = tweepy.API(authapp) #認証(ここではapi) def remove_emoji(src_str): return ''.join(c for c in src_str if c not in emoji.UNICODE_EMOJI) def get_tag(tw,text_content): taglist=[] entities=eval(str(tw.entities))["hashtags"] for e in entities: text=e["text"] taglist.append(text) for _ in range(len(taglist)+2): for s in taglist: text_content=re.sub(s,"",text_content) #text_content=re.sub(r"#(.+?)+ ","",text_content) return taglist,text_content def get_swap_dict(d): return {v: k for k, v in d.items()} def xcut(asub,a): asub.append(a[0]) a=a[1:len(a)] return asub,a def ycut(asub,a): asub.append(a[0]) a=a[1:len(a)] return asub,a def bunruikugiri(lastx,lasty): hoge=[] #import pdb; pdb.set_trace() editx=[] edity=[] for _ in range(500): edity,lasty=ycut(edity,lasty) #target=sum(edity) for _ in range(500): target=sum(edity) #rint("sum",sum(editx),"target",target) if sum(editx)<target: editx,lastx=xcut(editx,lastx) elif sum(editx)>target: edity,lasty=ycut(edity,lasty) else: hoge.append(editx) editx=[] edity=[] if lastx==[] and lasty==[]: return hoge break all_appear_cate=[] all_unfound_word=[] all_kumiawase=[] nn=1 all_kakari_imi=[] def process(tw,ty): global nn wordnum_toword={} catenum_wordnum={} word_origin_num=[] mozisu=[] try: tw=re.sub("https?://[\w/:%#\$&\?\(\)~\.=\+\-]+","",tw) tw=tw.replace("#","") tw=tw.replace(",","") tw=tw.replace("\u3000","") #文字数合わせのため重要 tw=re.sub(re.compile("[!-/:-@[-`{-~]"), '', tw) parseocha=m.parse(tw) print(tw) l = [x.strip() for x in parseocha[0:len(parseocha)-5].split('\n')] bunrui_miti_sentence=[] for i, block in enumerate(l): if len(block.split('\t')) > 1: c=block.split('\t') d=c[1].split(",") #単語の処理過程 print(d,len(d)) if len(d)>9: if d[10] in ["する"]: word_origin_num.append(d[10]) bunrui_miti_sentence.append(d[8]) mozisu.append(len(d[8])) elif d[-1] in word_origin_num_to_cate: word_origin_num.append(int(d[-1])) wordnum_toword[int(d[-1])]=d[8] bunrui_miti_sentence.append(word_origin_num_to_cate[str(d[-1])]) mozisu.append(len(d[8])) else: #print("nai",d[8]) #未知語の表示 all_unfound_word.append(d[10]) bunrui_miti_sentence.append(d[8]) mozisu.append(len(c[0])) else: mozisu.append(len(c[0])) all_unfound_word.append(c[0]) bunrui_miti_sentence.append(c[0]) #else: # mozisu.append(l[]) #print("kouho",word_origin_num,"\n") #単語をオリジナル番号に #print(tw) #意味分類と未知語で作った文を見るなら for s in bunrui_miti_sentence: print(s," ",end="") print("\n") stn=0 cmd = "echo "+str(tw)+" | cabocha -f1" cmdtree="echo "+str(tw)+" | cabocha " proc = subprocess.Popen(cmd, stdout=subprocess.PIPE, stderr=subprocess.PIPE,shell=True) proctree = subprocess.Popen(cmdtree, stdout=subprocess.PIPE, stderr=subprocess.PIPE,shell=True) proc=proc.communicate()[0].decode('cp932') proctree=proctree.communicate()[0].decode('cp932') print(proctree) proclist=proc.split("\n") #print(proc) #f1情報 #print(proclist) #リスト化情報 procnumlist=[] wordlis=[] eachword="" num=0 for p in proclist: if p[0]=="*": f=p.split(" ")[1] t=p.split(" ")[2].replace("D","") procnumlist.append([f,t]) if eachword: wordlis.append([num,eachword]) num=num+1 eachword="" elif p=="EOS\r": wordlis.append([num,eachword]) num=num+1 eachword="" break else: #print("aaaaa",p.split("\t")[0]) eachword=eachword+p.split("\t")[0] tunagari_num_dict=dict(procnumlist) print(tunagari_num_dict) bunsetu_num_word=dict(wordlis) #print(bunsetu_num_word) bunsetu_mozisu=[] for v in bunsetu_num_word.values(): bunsetu_mozisu.append(len(v)) if sum(bunsetu_mozisu) != sum(mozisu): return #print("mozisu",mozisu) #print("bunsetumozi",bunsetu_mozisu) res=bunruikugiri(mozisu,bunsetu_mozisu) #print("res",res) nnn=0 small_cateandcharlist=[] big_cateandcharlist=[] for gc in res: for _ in range(len(gc)): print(bunrui_miti_sentence[nnn],end=" ") if bunrui_miti_sentence[nnn] in list(catedic.keys()): small_cateandcharlist.append(bunrui_miti_sentence[nnn]) nnn=nnn+1 #未知語や助詞も同じものだとみなされているからmecabnegold辞書使えそう if small_cateandcharlist==[]: big_cateandcharlist.append(["null"]) else: big_cateandcharlist.append(small_cateandcharlist) small_cateandcharlist=[] print("\n") #print("bcacl",big_cateandcharlist) twewtnai_kakari_imi=[] if len(big_cateandcharlist)>1 and len(big_cateandcharlist)==len(bunsetu_num_word): #係り受け、形態素解析の区切りが一致しない for kk, vv in tunagari_num_dict.items(): if vv != "-1": for aaw in big_cateandcharlist[int(kk)]: for bbw in big_cateandcharlist[int(vv)]: twewtnai_kakari_imi.append([aaw,bbw]) if not "順位記号" in str([aaw,bbw]): if not "null" in str([aaw,bbw]): if not "数記号" in str([aaw,bbw]): if not "事柄" in str([aaw,bbw]): all_kakari_imi.append(str([aaw,bbw])) akiopen.write(str([aaw,bbw])) else: break else: return akiopen.write("\n") akiopen.write(str(bunrui_miti_sentence)) akiopen.write("\n") akiopen.write(str(tw)) akiopen.write("\n") print("tki",twewtnai_kakari_imi) tweetnai_cate=[] word_cate_num=[] for k in word_origin_num: if str(k) in word_origin_num_to_cate: ram=word_origin_num_to_cate[str(k)] print(ram,cate_rank[ram],end="") tweetnai_cate.append(ram) all_appear_cate.append(ram) word_cate_num.append(catedic[ram]) catenum_wordnum[catedic[ram]]=int(k) stn=stn+1 else: if k in ["する"]: all_appear_cate.append(k) tweetnai_cate.append(k) print("\n") #print(tweetnai_cate) #import pdb; pdb.set_trace() for k in tweetnai_cate: if k in catedic: aac=catedic[k] #print("gyaku",word_cate_num) #print("wt",wordnum_toword) #print("cw",catenum_wordnum) bunrui01open.write(str(tw)) bunrui01open.write(",") bunrui01open.write(str(tim)) bunrui01open.write(",") bunrui01open.write(str(unix)) bunrui01open.write(",") ps=0 for tt in list(range(544)): if int(tt) in word_cate_num: a=catenum_wordnum[tt] #かてごりから単語番号 bunrui01open.write(str(wordnum_toword[a])) #単語番号から単語 bunrui01open.write(",") ps=ps+1 else: bunrui01open.write("0,") bunrui01open.write("end") bunrui01open.write("\n") textopen.write(str(nn)) textopen.write(" ") textopen.write(tw) textopen.write("\n") nn=nn+1 #全ての通りを入れる for k in list(itertools.combinations(tweetnai_cate,2)): all_kumiawase.append(k) except Exception as ee: print(ee) import pdb; pdb.set_trace() pass def judge_tweet_type(tweet): if tweet.in_reply_to_status_id_str: return "reply" else: head= str(tweet.text).split(":") if len(head) >= 2 and "RT" in head[0]: return "retwe" else: return "tweet" #リプ、リツイート、ツイートか判断 def get_time(id): two_raw=format(int(id),'016b').zfill(64) unixtime = int(two_raw[:-22],2) + 1288834974657 unixtime_th = datetime.datetime.fromtimestamp(unixtime/1000) tim = str(unixtime_th).replace(" ","_")[:-3] return tim,unixtime #idからツイート時間 N=1 def gather(tweet,type,tweet_typea): global all_appear_cate global N global all_time global tim global unix tim,unix=get_time(tweet.id) original_text=tweet.text.replace("\n","") taglist,original_text=get_tag(tweet,original_text) nowtime=time.time() tweet_pertime=str(round(N/(nowtime-all_time),1)) lag=str(round(nowtime-unix/1000,1)) #lang=lang_dict[tweet.lang] try: process(remove_emoji(original_text),tweet_typea,) except Exception as e: print(e) #import pdb; pdb.set_trace() pass print(N,tweet_pertime,"/s","+"+lag,tim,type,tweet_typea) N=N+1 if N%500==0: ccdd=collections.Counter(all_appear_cate).most_common() for a in ccdd: print(a) #ccdd=collections.Counter(all_unfound_word).most_common() #for a in ccdd: # print("ない",a) ccdd=collections.Counter(all_kumiawase).most_common(300) for a in ccdd: print(a) ccdd=collections.Counter(all_kakari_imi).most_common(300) for a in ccdd: print("all_kakari_imi",a) #import pdb; pdb.set_trace() #streamとsearchの全ツイートが集まる def pre_gather(tw,ty): #print(ty) # if "http://utabami.com/TodaysTwitterLife" in tw.text: print(tw.text) if ty=="stream": tweet_type=judge_tweet_type(tw) if tw.lang=="ja" and tweet_type=="tweet": gather(tw,ty,tweet_type) elif ty=="search": gather(tw,ty,"tweet") def search(last_id): time_search =time.time() for status in apiapp.search(q="filter:safe OR -filter:safe -filter:retweets -filter:replies lang:ja",count="100",result_type="recent",since_id=last_id): pre_gather(status,"search") #search本体 class StreamingListener(tweepy.StreamListener): def on_status(self, status): global time_search global trysearch pre_gather(status,"stream") time_stream=time.time() time_stream-time_search % interval if time_stream-time_search-interval>interval*trysearch: last_id=status.id #executor = concurrent.futures.ThreadPoolExecutor(max_workers=2) #executor.submit(search(last_id)) search(last_id) trysearch=trysearch+1 #streaming本体 def carry(): listener = StreamingListener() streaming = tweepy.Stream(auth, listener) streaming.sample() interval = 2.1 trysearch=0 time_search =time.time() #executor = concurrent.futures.ThreadPoolExecutor(max_workers=2) all_time=time.time() try: #executor.submit(carry) carry() except Exception as er: print(er) import pdb; pdb.set_trace() pass500ツイートごとに、

単純な意味の出現数

2-gramの意味の出現数

2-gram間の係り受けのある意味連続?の出現数

また全てに、

ツイート本文、Unidic解析情報、CaboCha係り受け、意味分類との置き換えなどあります。bunrui01.csvー横軸に544の意味分類、縦軸にツイートで、0は存在しない、1は該当する単語となるよう書き込むcsvです

all_tweet_textー処理ツイートとそれが何番目か

all_kakari_imiー係り受け意味ペア、意味分類置き換え、本文

categori.txtー544の意味分類を記したtxtで実行時にindexで辞書を作ります。

BunruiNo_LemmaID_ansi_user.csvーは詳しくはhttps://pj.ninjal.ac.jp/corpus_center/goihyo.html

を見れば分かるのですが、単語オリジナルNoと意味分類の対応表です。

cate_rank2.csvーある時に作った意味分類の出現順辞書です。他の変数の説明はまた後ほど、、

自分のメモ用で、分かる人は頑張って理解してというくらいなのでこれくらいにします。

- 投稿日:2020-11-16T17:35:20+09:00

FirebaseでiOSのプッシュ通知を実装

始めに

iOS アプリでプッシュ通知機能を実装しようと思ったら、想定より苦戦したので、振り返ってみようと思います。

Firebase プロジェクトを作成する

Firebase コンソールで [プロジェクトを追加] をクリックし、 [プロジェクト名] を選択して、新しいプロジェクト名を入力します。

アプリを Firebase に登録する

- Firebase プロジェクトを作成したら、プロジェクトに iOS アプリを追加できます。 Firebase コンソールから、 [プロジェクトページ] に移動して、中央にある iOS アイコンをクリックして設定ワークフローを起動します。

- アプリのバンドル ID を [iOS バンドル ID] フィールドに入力します。このバンドル ID を探すには、 XCode でアプリを開き、最上位のディレクトリの [General] タブにアクセスします。[bundle identifier] フィールドの値が iOS バンドル ID です(例: com.atsushi-uchida.NewsTwit)。

Firebase 構成ファイルを追加する

- [Download GoogleService-Info.plist] をクリックして、Firebase iOS 構成ファイル(GoogleService-Info.plist)を取得します。

- 構成ファイルを Xcode プロジェクトのルートに移動します。メッセージが表示されたら、構成ファイルをすべてのターゲットに追加するオプションを選択します。

アプリに Firebase SDK を追加する

Firebase ライブラリのインストールにはCocoaPodsを使用することをおすすめします。

・ Podfile がない場合は作成します。$ cd your-project-directory$ pod init・ アプリで使用したいポッドを Podfile に追加します。たとえば、アナリティクスの場合は次のようになります。

$ pod 'Firebase/Analytics'これにより、iOS アプリで Firebase を稼働させるために必要なライブラリが、Firebase 向け Google アナリティクスとともに追加されます。

・ ポッドをインストールし、.xcworkspace ファイルを開いて Xcode でプロジェクトを確認します。

$ pod install$ open your-project.xcworkspace・ 注意!!!一度でも、CocoaPods でポッドをインストールをした事がある場合は、インストールではアップデートにします。

$ pod update2回目以降も、インストールを使用すると、依存性でエラーになる事が多いです。

証明書を発行編に移ります

プッシュ通知を送るために作成するもの・しておくことは以下の7つあります。

- CSRファイルの作成 ※初回作成すれば後は同じものを使いますので改めて作成不要です

- 開発用証明書(.cer)の作成 ※初回作成すれば後は同じものを使いますので改めて作成不要です

- AppIDの作成

- 端末の登録

- プロビショニングプロファイルの作成

- APNs用証明書(.cer)の作成

- APNs用証明書(.p12)の作成

1. CSRファイルの作成

- キーチェーンアクセスを開きます

- 「キーチェーンアクセス」>「証明書アシスタント」>「認証局に証明書を要求」をクリックします

- 「ユーザーのメールアドレス」を入力します

- (「通称」はそのまま、「CAのメールアドレス」は空欄でOK)

- 「要求の処理」は「ディスクに保存」を選択し「鍵ペア情報を設定」にチェックを入れます

- 「続ける」をクリックします

- 保存先の選択が出るので任意の場所を選択し「保存」をクリックします

- 「鍵ペア情報」画面を確認して「続ける」をクリックします

- 「設定結果」画面が出るので「完了」をクリックします

2. 開発用証明書(.cer)の作成

- Apple Developer Programにログインします

- 「Certificates, Identifiers & Profiles」をクリックします

- 「Certificates」をクリックし、「Certificates」の隣にある「+」をクリックします

- 「Create a New Certificate」画面が表示されるので設定していきます

- 「iOS App Development」にチェックをいれ、右上の方の「Continue」をクリックします

- 「Choose File」をクリックして、1.で作成した「CSRファイルの作成」を選択し、「Continue」をクリックします

- 開発者用証明書が作成されるので、「Download」をクリックして書き出しておきます

- 開発用証明書(.cer)の作成は完了です

3. App ID の作成

- 2. 「開発用証明書(.cer)の作成」の作業がスキップだった場合は、Apple Developer Programにログインして、「Certificates, Identifiers & Profiles」をクリックします(※2.の画像参照)

- 「Identifiers」の右の「+」をクリックします

- 「Register a New Identifier」が表示されるので「App IDs」にチェックをいれ、右上の方の「Continue」をクリックします

- 「Description」にアプリの概要を記入します 例) TestPushApp

- 「Bundle ID」では「Explicit」を選択し、「Bundle ID」を入力します 6「Wildcard」を選択するとプッシュ通知が利用できないので注意!

- 「Bundle ID」は アプリ側で同じものを設定します ので必ず控えておきましょう!

- 下にスクロールして「Capabilities」の「Push Notifications」にチェックを入れます

- これを忘れるとプッシュ通知が利用できないので注意!

- 「Continue」をクリックします

- 確認画面が表示されるので「Push Notifications」にチェックが入っている事を確認して「Register」をクリックします

- これでApp ID 作成は完了です

4. 端末の登録

- 「Devices」をクリックして、「Devices」の隣にある「+」をクリックします

- 「Platform」は「iOS, tvOS, WatchOS」に選択します

- 端末の「Device Name」と「Device ID(UDID)」を入力します

- 「Device Name」は自由に設定できます

- 「Device ID(UDID)」はXcodeを使うと確認し易いです

- Mac に端末を接続し、Xcodeを起動します

- 「Window」>「Devices and Simulators」をクリックします

- 「identifier」としてUDIDが確認できます

- 記入できたら「Continue」をクリックします

- 次の画面で端末情報を確認して「Register」をクリックします

- これで端末登録は完了です

5. プロビショニングプロファイルの作成

- 「Profiles」をクリックして、「Profiles」の隣にある「+」をクリックします

- 「Development」の「iOS App Development」を選択し、「Continue」をクリックします

- 利用する App ID、開発用証明書、端末をそれぞれ紐付けていきます

- 3.「App ID の作成」で作成したApp IDを選択し、「Continue」をクリックします

- 2.「開発用証明書(.cer)の作成」で作成した(あるいは既存の) 開発用証明書 を選択し、「Continue」をクリックします

- 4.「端末の登録」で登録した(あるいは既存の)端末を選択し、「Continue」をクリックします

- 最後に「Provisioning Profile Name」にファイル名入力します 例) TestPushApp Provisioning Profiles

- 紐付けを確認し「Generate」をクリックします

- プロビショニングプロファイルがが作成されるので、「Download」をクリックして書き出しておきます

- プロビショニングプロファイルの作成は完了です

6. APNs用証明書(.cer)の作成

- 「Certificates」をクリックして、「Certificates」の隣にある「+」をクリックします

- 2.「開発用証明書(.cer)の作成」で開発用証明書を作成したときとは異なり、下にスクロールし、「Service」の「Apple Push Notification service SSL (Sandbox)」をチェックに入れます

- 「Continue」をクリックします

- 3.「App ID の作成」で作成した App ID を選択し、「Continue」をクリックします

- 1.「CSRファイルの作成」で作成した(あるいは既存の)CSRファイルを選択し、「Continue」をクリックします

- APNs用証明書(.cer) が作成されるので、「Download」をクリックして書き出しておきます

- APNs用証明書(.cer) の作成は完了です

7. APNs用証明書(.p12) の作成

- 6.「APNs用証明書(.cer)の作成」で作成した「APNs用証明書(.cer)」をダブルクリックしてキーチェーンアクセスを開きます

- APNs用証明書(.cer) の左にある三角マークをクリックして開きます

- APNs用証明書(.cer) ファイルには鍵がセットされています

- APNs用証明書(.p12) を書き出すには、開いた状態で 鍵ではなく証明書の上で右クリック をして「~を書き出す…」をクリックします

- ファイル名「名前」と保存先「場所」を指定して「保存」をクリックします

- パスワードを求められますが、 何も入力しない で「OK」をクリックします

- この後、システム側にパスワードを求められる場合があります。対応してください。

- APNs用証明書(.p12) が書き出されます

- APNs用証明書(.p12) 作成は完了です

- これですべて必要なファイルが作成できました

FirebaseのCloud MessagingにAPNs証明書を登録

- 次にFirebaseの設定画面に移動します。

- Firebase Consoleの対象のプロジェクトの画面左上部の歯車のアイコンを選択して、プロジェクトの設定を選択します。

- SettingメニューのCloud Messagingを選択します。

- 画面スクロールしIOSアプリの設定のAPNs証明書の開発用APNs証明書のアプロードを選択します。

- ファイルをアップロードをクリックし、7. 「APNs用証明書(.p12) の作成」で作成したAPNs証明書を選択してップロードを選択します。

- こちらでアップロードが完了すればFirebaseの設定は完了です。

XcodeのSigningを設定

- 次にXcodeの設定を行います。Xcodeのこちらの画面を開き、Signing & Capabilityを選択します。

- まずAutomatically manage signingのチェックを外し、Provisioning Profileに5. 「プロビショニングプロファイルの作成」で作成したProvisioning Profileを設定します。

- 次に+CapabilityをクリックしてPush NortificationsをSigningのした後にドラッグアンドドロップします。

- 同様にBackgroundModeもドラックアンドドロップします。

- Background ModeのRemote nortificationsにチェックを入れます。こちらでXcodeの設定は完了です。

AppDelegate.swiftに通知の許可やDeviceの登録する処理を実装

最後にAppDelegateに処理を書いて終わりになります。

実装箇所は4箇所です。

1. import

2. didFinishLaunchingWithOptions

3. AppDelegateのクラス内

4. UNUserNotificationCenterDelegateのExtensionimport UIKit import Firebase import FirebaseMessaging import UserNotifications @UIApplicationMain class AppDelegate: UIResponder, UIApplicationDelegate { func application(_ application: UIApplication, didFinishLaunchingWithOptions launchOptions: [UIApplication.LaunchOptionsKey: Any]?) -> Bool { // Override point for customization after application launch. FirebaseApp.configure() if #available(iOS 10.0, *) { // For iOS 10 display notification (sent via APNS) UNUserNotificationCenter.current().delegate = self let authOptions: UNAuthorizationOptions = [.alert, .badge, .sound] UNUserNotificationCenter.current().requestAuthorization( options: authOptions, completionHandler: {_, _ in }) } else { let settings: UIUserNotificationSettings = UIUserNotificationSettings(types: [.alert, .badge, .sound], categories: nil) application.registerUserNotificationSettings(settings) } application.registerForRemoteNotifications() return true } // MARK: UISceneSession Lifecycle func application(_ application: UIApplication, configurationForConnecting connectingSceneSession: UISceneSession, options: UIScene.ConnectionOptions) -> UISceneConfiguration { // Called when a new scene session is being created. // Use this method to select a configuration to create the new scene with. return UISceneConfiguration(name: "Default Configuration", sessionRole: connectingSceneSession.role) } func application(_ application: UIApplication, didDiscardSceneSessions sceneSessions: Set<UISceneSession>) { // Called when the user discards a scene session. // If any sessions were discarded while the application was not running, this will be called shortly after application:didFinishLaunchingWithOptions. // Use this method to release any resources that were specific to the discarded scenes, as they will not return. } func application(_ application: UIApplication, didReceiveRemoteNotification userInfo: [AnyHashable: Any]) { // Print message ID. if let messageID = userInfo["gcm.message_id"] { print("Message ID: \(messageID)") } // Print full message. print(userInfo) } func application(_ application: UIApplication, didReceiveRemoteNotification userInfo: [AnyHashable: Any], fetchCompletionHandler completionHandler: @escaping (UIBackgroundFetchResult) -> Void) { // Print message ID. if let messageID = userInfo["gcm.message_id"] { print("Message ID: \(messageID)") } // Print full message. print(userInfo) completionHandler(UIBackgroundFetchResult.newData) } } @available(iOS 10, *) extension AppDelegate : UNUserNotificationCenterDelegate { func userNotificationCenter(_ center: UNUserNotificationCenter, willPresent notification: UNNotification, withCompletionHandler completionHandler: @escaping (UNNotificationPresentationOptions) -> Void) { let userInfo = notification.request.content.userInfo if let messageID = userInfo["gcm.message_id"] { print("Message ID: \(messageID)") } print(userInfo) completionHandler([]) } func userNotificationCenter(_ center: UNUserNotificationCenter, didReceive response: UNNotificationResponse, withCompletionHandler completionHandler: @escaping () -> Void) { let userInfo = response.notification.request.content.userInfo if let messageID = userInfo["gcm.message_id"] { print("Message ID: \(messageID)") } print(userInfo) completionHandler() } }コピペでできると思いますので、そのように実装してください。

こちらでコードの設定も完了です。

アプリを実機に接続して、アプリを起動し、通知の許可のダイアログが出ると思うので許可した状態で置いておいてください。(通知の許可がないと通知が届きません。+リモートの通知は実機でないと届かないです。)Cloud Messagingより通知を送信する

- あとは通知を送信するだけです!Firebase Console左メニューよりCloud Messagingを選択します。

- Send your firdt messageをクリックし、通知する内容を入力します。(適当で大丈夫です。) 次へをクリックします。

- アプリを選択から自分のアプリを選択して次へをクリックします。

- スケジュールは細かく設定できますが、今は現在で大丈夫です。次へをクリックします。

- コンバージョンイベントは特に何も設定せず次へをクリックします。

- 最後は通知音のON、OFFやIOSバッチ(アプリ右上につく赤い丸いやつ)の数量など細かく設定できます。設定はお任せします。問題なければ確認をクリックします。

- 最後に公開をクリックすると通知はが発送され、実機に通知が届きます。

- 以上で設定と通知が完了しました。

プッシュ通知が正しく配信されない場合

- 書類の作成順序を間違えている

- 途中で作成した書類を編集した

- 開発用証明書が複数作成されている

- CSRファイルが複数作成されている

- AppIDを作成時に「Push Notifications」にチェックを入れ忘れている

- 実機でアプリが開きっぱになっていないか確認(アプリが開いてると届かないです。)

- 通知の許可がうまくできていない可能性あるので、アプリを一度削除して再インストールする

- Info.plistに変な設定をしていないか確認する。(記事によってはInfo.plistに設定が必要と書いてありますが特に必要ないです。)

Firebase Admin SDKを使ったPush通知

Firebase Cloud Messaging (FCM)を利用して、サーバからスマホへのPush通知を試してみました。サーバからFirebase経由でPush通知を送信する方法を書いていきます。

Firebase Admin SDKをインストール

$ pip install firebase-adminサービス アカウントを認証して Firebase サービスへのアクセスを承認するには、秘密鍵ファイルを JSON 形式で生成する必要があります。

Firebase consoleからfirebase接続用の鍵ファイルを取得

- Firebase コンソールの左上にある歯車マークを押して、プロジェクトの設定画面を開きます。

- この画面から「サービスアカウント」のタブをクリックします。

- 「新しい秘密鍵の生成」ボタンを押すと、秘密鍵のファイルがダウンロードされます。

- キーを含む JSON ファイルを安全に保管します。

特定のスマホにPush通知

特定のスマホ(YOUR_REGISTRATION_TOKEN)へPush通知を送信します。

コードは以下です。path/to/serviceAccountKey.jsonは、ダウンロードした秘密鍵のファイルを指定します。import firebase_admin from firebase_admin import credentials from firebase_admin import messaging cred = credentials.Certificate("path/to/serviceAccountKey.json") firebase_admin.initialize_app(cred) # This registration token comes from the client FCM SDKs. registration_token = 'YOUR_REGISTRATION_TOKEN' # See documentation on defining a message payload. message = messaging.Message( notification=messaging.Notification( title='test server', body='test server message', ), token=registration_token, ) # Send a message to the device corresponding to the provided # registration token. response = messaging.send(message) # Response is a message ID string. print('Successfully sent message:', response)トピックに参加しているスマホにPush通知

特定のトピックに参加している複数のスマホにPush通知する方法です。

例えば、"weather"のトピックに参加しているスマホにPush通知するときは、メッセージの作成部分を以下のように変更します。

具体的には、tokenの部分をtopicに変更するだけです。message = messaging.Message( notification=messaging.Notification( title='test server', body='test server message', ), topic='weather', )iosでトピックへの参加は、AppDelegate.swiftに以下のようなコードで実現できます。

Messaging.messaging().subscribe(toTopic: "weather") { error in print("Subscribed to weather topic") }応用編 アイコン右上の数字(バッジ表示)をつける

今までは、タイトルとメッセージのみでしたが、バッジ処理(アイコン右上の数字)もつけてみようと思います。

以下のようなコードで実現できます。import firebase_admin from firebase_admin import credentials from firebase_admin import messaging cred = credentials.Certificate("path/to/serviceAccountKey.json") firebase_admin.initialize_app(cred) notification = messaging.Notification( title='test server', body='test server message', ) topic='weather' apns = messaging.APNSConfig( payload = messaging.APNSPayload( aps = messaging.Aps(badge = 1) # ここがバックグランド通知に必要な部分 ) ) message = messaging.Message( notification=notification, apns=apns, topic=topic, ) response = messaging.send(message) print('Successfully sent message:', response)終わりに

振り返ってみましたが、かなりの文字数になってしまいました。

それほど、大変ってことですかね?

長文を読んでくれて、ありがとうございました。

以下が参考にさせて頂いたリンクになります。

1. Firebase を iOS プロジェクトに追加する

2. 【Swift5】リモートプッシュ通知の実装方法

3. プッシュ通知に必要な証明書の作り方2020

4. Firebase Admin SDKを使ったPush通知

- 投稿日:2020-11-16T16:57:48+09:00

[Python]決定木の理論と実装を徹底解説してみた

はじめに

今回は、決定木の理論についてまとめていきます。

お付き合い頂ければ幸いです。

理論編

それでは最初に、決定木の理論についてまとめていきます。

決定木の概要

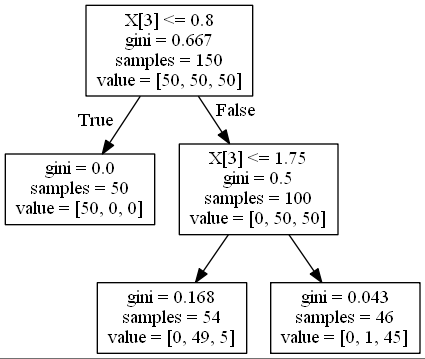

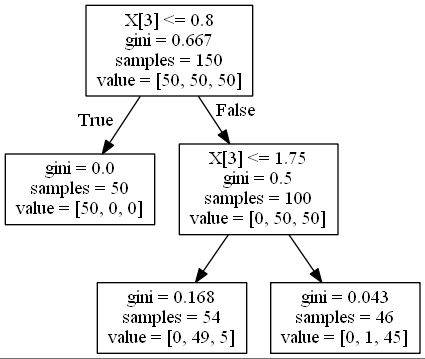

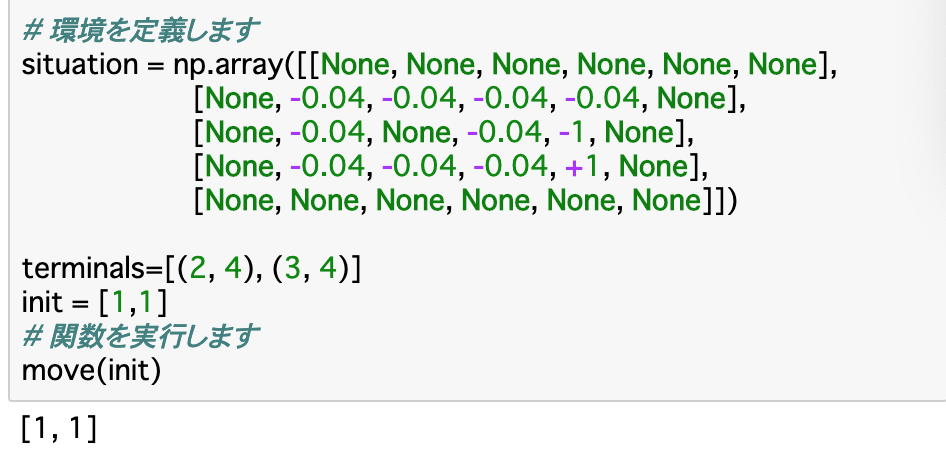

決定木の可視化すると以下のようになります。

今回はirisデータセットによる分類を

scikit-learnのexport_graphvizを用いて可視化しました。

決定木とは、上の画像のようにデータをある条件に従って分割することにより、データの分類または回帰のモデルを作成するアルゴリズムです。分類を行う分類木と回帰を行う回帰木を総称して決定木と呼びます。

かなりシンプルなアルゴリズムのため、他の複雑なアルゴリズムと比較すると精度は出にくい傾向にあります。

しかし、モデルの解釈性が非常に高いです。

モデルの見た目が上の図のように木のように見えることから、決定木と呼ばれています。

代表的なアルゴリズムに

CARTやC5.0などがあります。アルゴリズムについてはこちらの記事を参考にしてください。

ここでは、ニクラス分類を繰り返し行う

CARTのアルゴリズムを取り扱っていきます。決定木の基準について

ここまでで決定木のおおよその概要をつかめたと思います。

ここでは、分類木と回帰木の枝分かれの基準について考えていきます。

分類木の基準

それでは、分類木はどのような判断基準に従って枝分かれさせていくのかを考えていきましょう。

結論から書くと、分類は

不純度が最小になるような分割をする、という基準に基づいて特徴量や閾値を決めています。

不純度とはどれくらい多くのクラスが混じりあっているかを数値にしたもので、誤分類率やジニ指数、交差エントロピー誤差を用いて表されます。一つのノードに一つのクラスの観測地がある状態のとき、不純度は0になります。回帰木の基準

回帰木は、平均二乗誤差で表されるコスト関数を定義し、そのコスト関数の重み付き和が最小となるように特徴量や閾値を選択します。

数式について

分類木

不純度を数式を用いて表してみましょう。以下の図について考えます。

$N_m$個の観測値を持つ領域$R_m$におけるクラスkの観測値の割合を以下のように定義します。

\hat{p}_{mk} = \frac{1}{N_m} \sum_{x_i\in R_m}^{}I(y_i = k)図の上から三番目の段に注目します。mは領域の番号を表しており、m=1で

gini=0.168の領域を表し、m=2でgini=0.043の領域を表しています。kはクラスラベルを表していて、今回はvalueの部分の左からクラス1、クラス2、クラス3と定義しています。数式にすると難しそうですが、実際に計算すると以下のようになります。

\hat{p}_{11} = \frac{0}{54} \quad \hat{p}_{12} = \frac{49}{54} \quad \hat{p}_{13} = \frac{5}{54}なんとなく数式の意味が理解できたでしょうか。

この$\hat{p}$を用いて、以下の三つの関数で不純度を表現します。

誤分類率

\frac{1}{N_m} \sum_{x_i\in R_m}^{}I(y_i \neq k(m)) = 1-\hat{p}_{mk}ジニ指数

1 - \sum_{k=1}^{K}\hat{p}_{mk}交差エントロピー誤差

-\sum_{k=1}^{K}\hat{p}_{mk}log\hat{p}_{mk}

sklearnで標準で用いる不純度の関数はジニ指数になっているので、実際にジニ指数を計算してみましょう。三段目の不純度をジニ指数を用いて計算します。

左の

gini=0.168のノードのジニ指数は以下の式になりますね。1 - (\frac{0}{54})^2 - (\frac{49}{54})^2 - (\frac{5}{54})^2 = 0.168当然答えは0.168になります。上の式がsklearnが内部で行っている計算式になります。ついでに右の

gini=0.043のノードの計算も行いましょう。1 - (\frac{0}{46})^2 - (\frac{1}{46})^2 - (\frac{45}{46})^2 = 0.043こちらも一致しましたね。それでは、それぞれのにデータの重みをかけることで全体の不純度を計算しましょう。以下の式になります。

\frac{54}{100} ×0.168 + \frac{46}{100} ×0.043 = 0.111これで全体の不純度が導出できました。決定木はこの不純度を小さくするような特徴量や閾値を選択することにより、モデルを構築しています。

回帰木

回帰木において、コスト関数を以下のように定義します。

\hat{c}_m = \frac{1}{N_m}\sum_{x_i \in R_m}^{}y_i\\ Q_m(T) = \frac{1}{N_m} \sum_{x_i \in R_m}(y_i - \hat{c}_m)^2$\hat{c}_m$がそのノードに含まれる観測値の平均を表しているので、コスト関数は平均二乗誤差となります。

このコスト関数はそれぞれのノードについて計算されるため、そのコスト関数の重み付き和が最小となるように特徴量や閾値を設定します。

実装編

ここまでで、分類木と回帰木の理論が理解できたと思います。

それでは、これから決定木の実装を行っていきましょう。

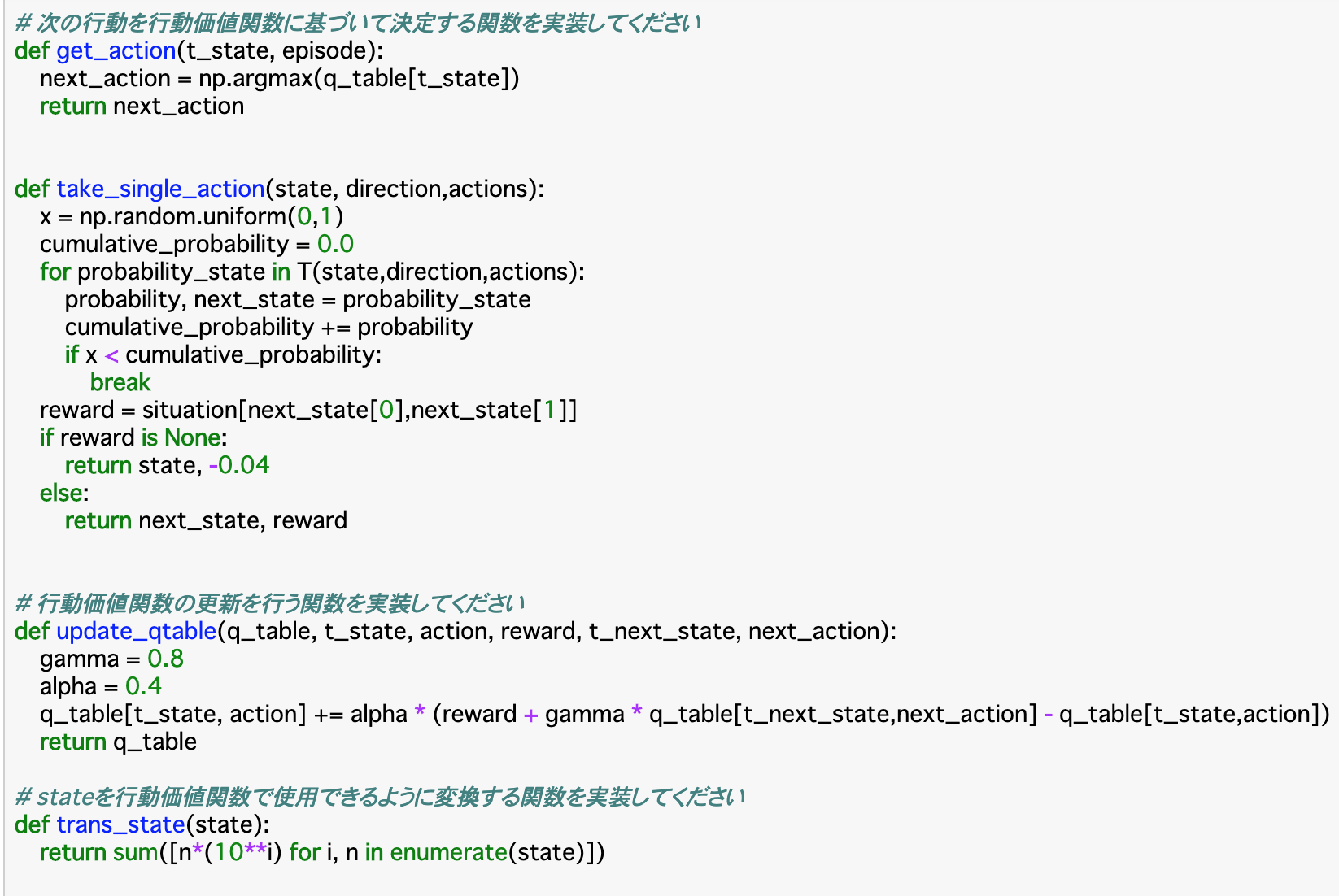

分類木の実装

それでは分類木を実装しています。

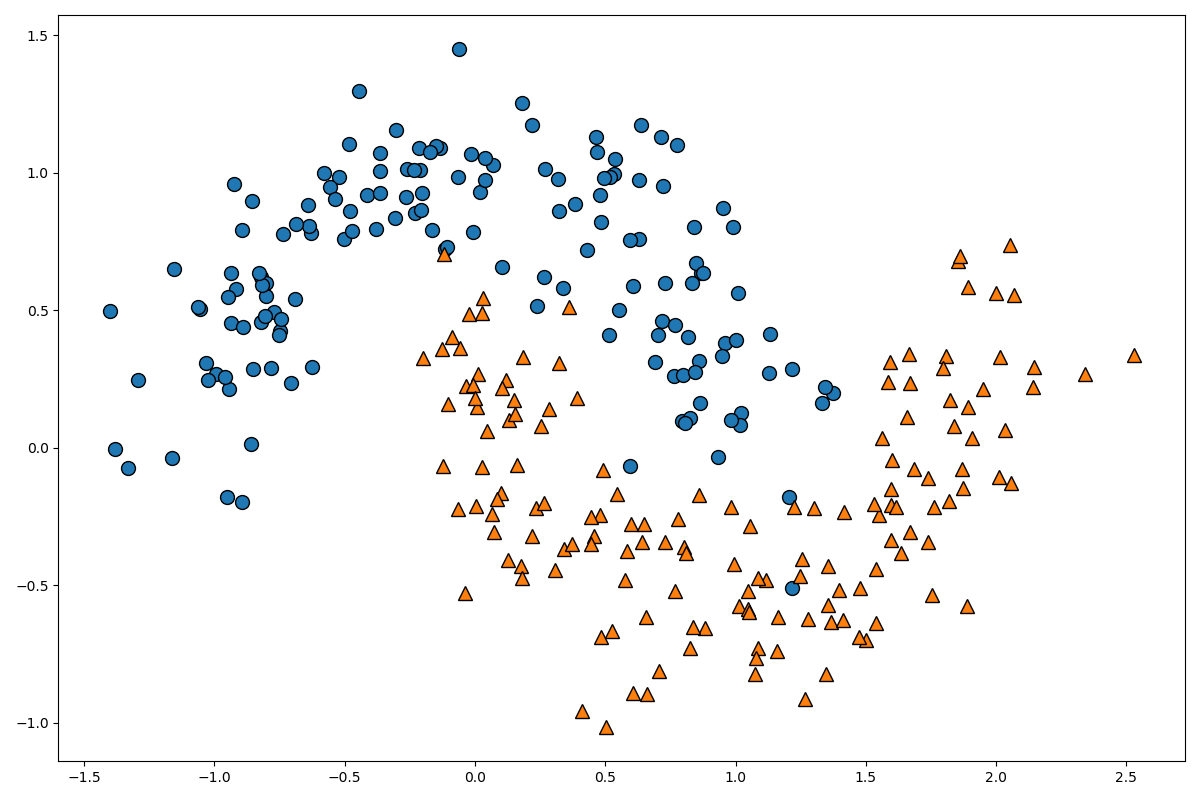

まず、分類するデータを作成します。

from sklearn.datasets import make_moons from sklearn.model_selection import train_test_split from sklearn.tree import DecisionTreeClassifier from sklearn.tree import export_graphviz from matplotlib.colors import ListedColormap import graphviz moons = make_moons(n_samples=300, noise=0.2, random_state=0) X = moons[0] Y = moons[1] X_train, X_test, Y_train, Y_test = train_test_split(X, Y, random_state=0, stratify=Y) plt.figure(figsize=(12, 8)) mglearn.discrete_scatter(X[:, 0], X[:, 1], Y) plt.show()このデータを分類するモデルを作成していきます。

以下のコードです。

clf_model = DecisionTreeClassifier(max_depth=3) clf_model.fit(X_train, Y_train) print(clf_model.score(X_test, Y_test))0.8933333333333333

そこそこの精度がでましたね。

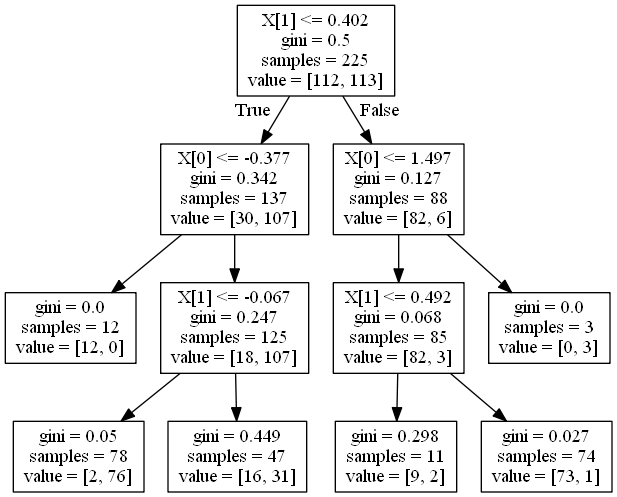

この分類木のモデルを可視化してみましょう。以下のコードです。

dot_data = export_graphviz(clf_model) graph = graphviz.Source(dot_data) graph.render('moon-tree', format='png')

graphvizを用いた可視化については、こちらの記事を参考にしてください。このように、決定木はモデルの解釈性が非常に高いです。今回のモデルでは

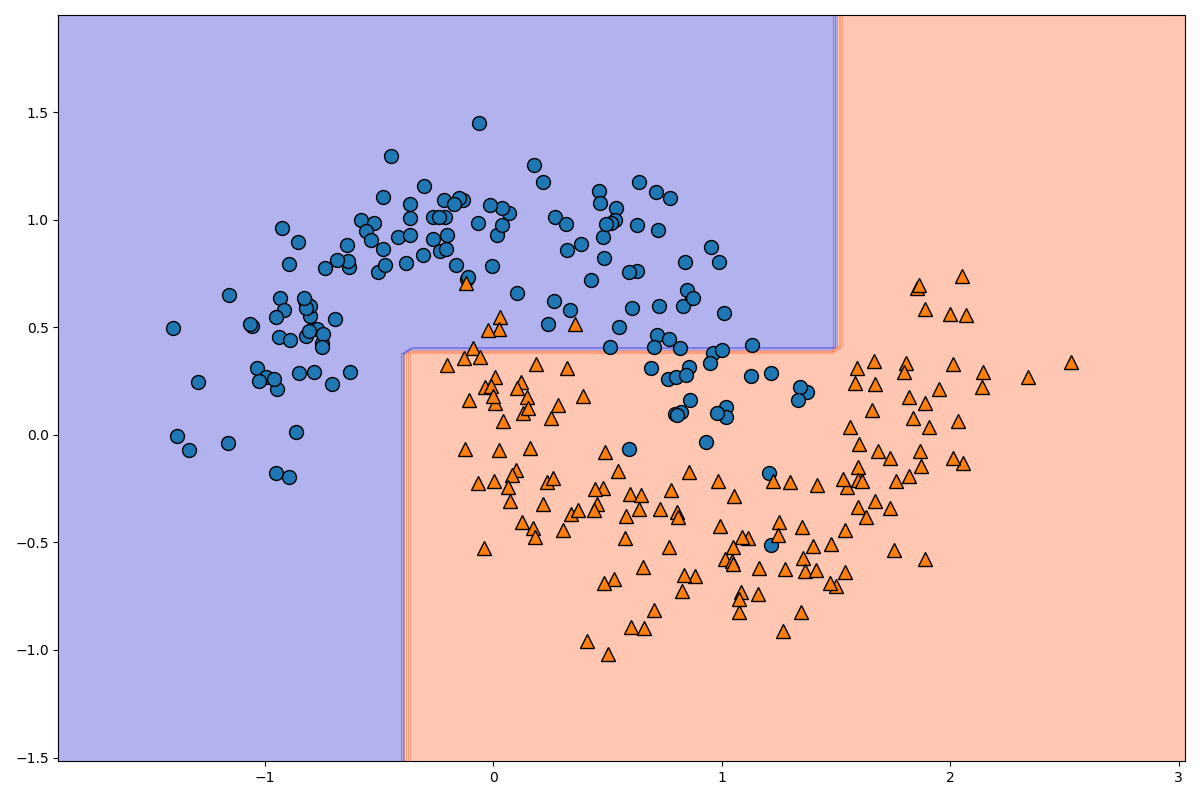

max_depth=3としたため、深さが3のモデルになっています。分類後のモデルを可視化してみましょう。以下のコードです。

plt.figure(figsize=(12, 8)) _x1 = np.linspace(X[:, 0].min() - 0.5, X[:, 0].max() + 0.5, 100) _x2 = np.linspace(X[:, 1].min() - 0.5, X[:, 1].max() + 0.5, 100) x1, x2 = np.meshgrid(_x1, _x2) X_stack = np.hstack((x1.ravel().reshape(-1, 1), x2.ravel().reshape(-1, 1))) y_pred = clf_model.predict(X_stack).reshape(x1.shape) custom_cmap = ListedColormap(['mediumblue', 'orangered']) plt.contourf(x1, x2, y_pred, alpha=0.3, cmap=custom_cmap) mglearn.discrete_scatter(X[:, 0], X[:, 1], Y) plt.show()格子点を用いて色を変化させる方法についてはこちらの記事を参考にしてください。

_x1と_x2でx軸方向とy軸方向の格子点の領域を指定し、x1, x2 = np.meshgrid(_x1, _x2)で格子点を作成しています。

X_stack = np.hstack((x1.ravel().reshape(-1, 1), x2.ravel().reshape(-1, 1)))の部分で100×100の格子点を一次元配列に変化させた後、10000×1の二次元配列に変換し、水平方向に結合して10000×2のデータに変換しています。

y_pred = clf_model.predict(X_stack).reshape(x1.shape)の部分で10000×2のデータを0と1のデータに変換し、それを100×100のデータに変換しています。データを分離する線の片側が0でもう一方が1になります。

plt.contourf(x1, x2, y_pred, alpha=0.3, cmap=custom_cmap)の部分で、等高線を描画します。色をcmap=custom_cmapで指定しています。ここまでで分類木の実装は終了です。

回帰木の実装

それでは回帰木の実装を行いましょう。

データを準備して描画してみましょう。

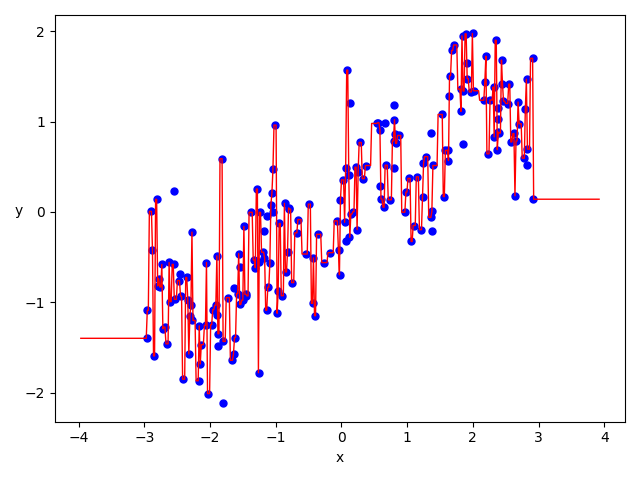

import mglearn from sklearn.tree import DecisionTreeRegressor import numpy as np import matplotlib.pyplot as plt from sklearn.tree import export_graphviz import graphviz X, Y = mglearn.datasets.make_wave(n_samples=200) plt.figure(figsize=(12, 8)) plt.plot(X, Y, 'bo', ms=15) plt.show()このようなデータになっています。それではモデルを作成しましょう。

tree_reg_model = DecisionTreeRegressor(max_depth=3) tree_reg_model.fit(X, Y) print(tree_reg_model.score(X, Y))0.7755211625482443

scoreで$R^2$を表示させることができます。score(self, X, y[, sample_weight]) Returns the coefficient of determination R^2 of the prediction.

あまり精度はよくありませんね。

次のコードでモデルを可視化してみましょう。

dot_data = export_graphviz(tree_reg_model) graph = graphviz.Source(dot_data) graph.render('wave-tree', format='png')このように、回帰木は(決定木もそうですが)モデルの解釈性がとても良いですね。

それでは、次のコードで回帰直線を図示してみましょう。

X1 = np.linspace(X.min() - 1, X.max() + 1, 1000).reshape(-1, 1) y_pred = tree_reg_model.predict(X1) plt.xlabel('x', fontsize=10) plt.ylabel('y', fontsize=10, rotation=-0) plt.plot(X, Y, 'bo', ms=5) plt.plot(X1, y_pred, 'r-', linewidth=3) plt.show()図示してみてわかる通り、あまり正しくはありませんね。

深さを指定せずに実装

それでは、次は深さを実装せずに実装してみましょう。

深さを指定しない以外は同じなので、同じ手順は関数にまとめましょう。

import mglearn from sklearn.tree import DecisionTreeRegressor import numpy as np import matplotlib.pyplot as plt from sklearn.tree import export_graphviz import graphviz X, Y = mglearn.datasets.make_wave(n_samples=200) tree_reg_model_2 = DecisionTreeRegressor() tree_reg_model_2.fit(X, Y) print(tree_reg_model_2.score(X, Y))1.0

$R^2$が1になりました。いったいどのようなモデルになっているのでしょうか。以下で分岐を図示しましょう。

def graph_export(model): dot_data = export_graphviz(model) graph = graphviz.Source(dot_data) graph.render('test', format='png') graph_export(tree_reg_model_2)恐ろしいほどの分岐になりました。もう、どのように分岐しているか読めませんね。

次のコードでモデルを図示しましょう。

def plot_regression_predictions(tree_reg, x, y): x1 = np.linspace(x.min() - 1, x.max() + 1, 500).reshape(-1, 1) y_pred = tree_reg.predict(x1) plt.xlabel('x', fontsize=10) plt.ylabel('y', fontsize=10, rotation=-0) plt.plot(x, y, 'bo', ms=5) plt.plot(x1, y_pred, 'r-', linewidth=1) plt.show() plot_regression_predictions(tree_reg_model_2, X, Y)上の図を見て頂ければ分かりますが、これは明らかに過学習になっていますね。

これでは未知のデータを予測することができないので、適切に木の深さを設定する大切さが理解できると思います。

終わりに

今回はここまでになります。

ここまでお付き合い頂きありがとうございました。

- 投稿日:2020-11-16T15:31:03+09:00

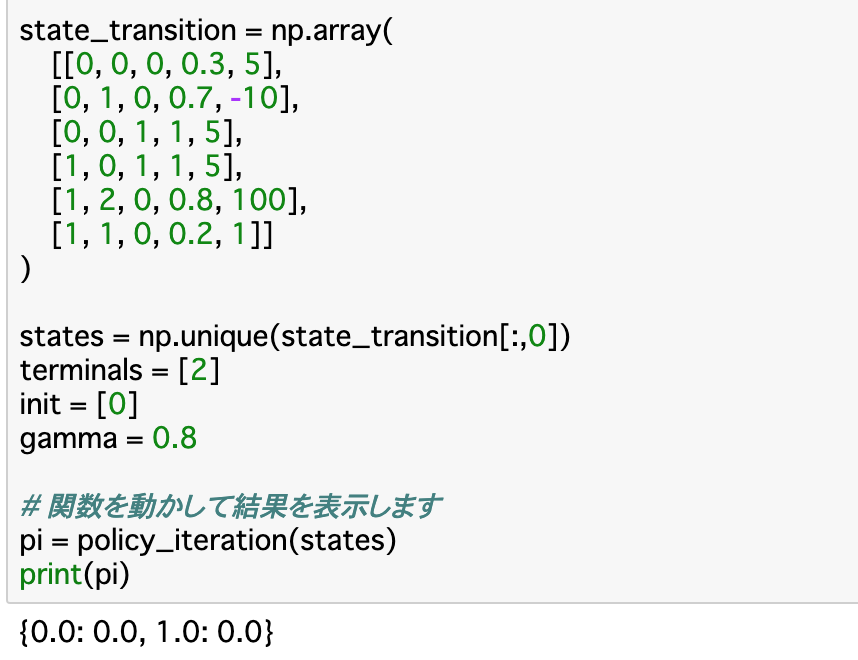

強化学習3 動的計画法・TD手法

Aidemy 2020/11/16

はじめに

こんにちは、んがょぺです!バリバリの文系ですが、AIの可能性に興味を持ったのがきっかけで、AI特化型スクール「Aidemy」に通い、勉強しています。ここで得られた知識を皆さんと共有したいと思い、Qiitaでまとめています。以前のまとめ記事も多くの方に読んでいただけてとても嬉しいです。ありがとうございます!

今回は、強化学習の3つ目の投稿になります。どうぞよろしくお願いします。*本記事は「Aidemy」での学習内容を「自分の言葉で」まとめたものになります。表現の間違いや勘違いを含む可能性があります。ご了承ください。

今回学ぶこと

・動的計画法について

・TD手法について動的計画法

動的計画法とは

・Chapter2ではベルマン方程式を使って最適な方策を見つけるということを説明したが、このChapterでは実際にこれを行っていく。

・環境のモデルが「マルコフ決定過程(MDP)」で完全に与えられているとするとき、最適な方策を求める手法を「動的計画法(DP)」という。方策評価

・手法$\pi$をとった時の価値関数$V^\pi(s)$を計算することを方策評価という。実行方法は以下の通り。

・まず方策を更新する際の閾値$\epsilon$を事前に設定する。そして方策$\pi$を入力し、$V(s)$を全ての状態において0と仮定し、更新時に全ての状態の差分が閾値よりも小さくするために、「$\delta$」を定義しておく。

・ここまで定義したら、全ての状態sについて、「v=$V(s)$」として、ベルマン方程式で「$V(s)$」を計算する。更新量を比較するために、あらかじめ定義しておいた「$\delta$」を「$\max(\delta,|v-V(s)|)$」に更新し、これが「$\epsilon$」を下回ったらその時点で計算を終了し、「$V(s)$」を「$V^\pi(s)$」の近似解と仮定して出力する。

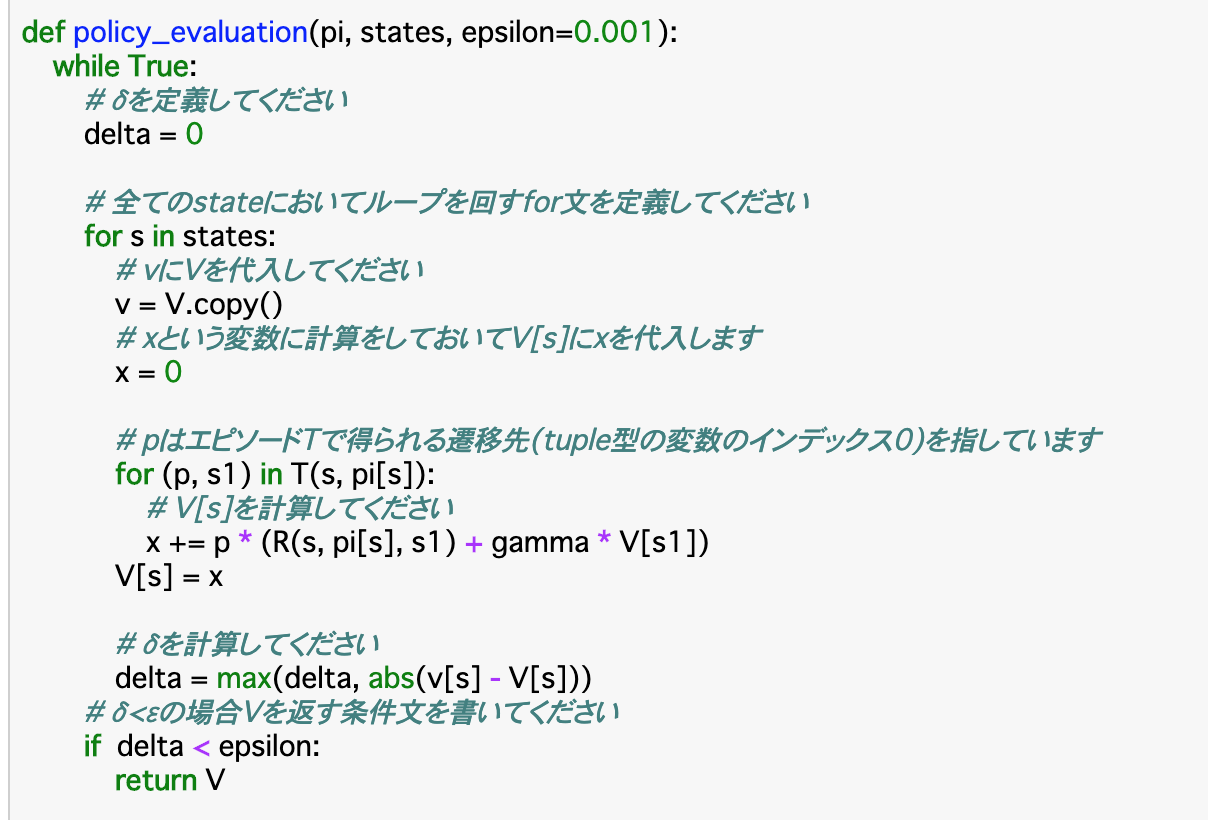

・以上についてのコードが以下である。・方策評価を行う関数「policy_evaluation()」について、引数には「方策pi、状態states、閾値epsilon」を渡す。

・はじめに「$\delta=0$」を定義する。そして、ここからは全ての状態sについて上記手法を行なっていく。まずは「v=V.copy()」で変数「v」に価値関数Vを代入する。また、次の計算で算出される「V[s]」を格納する変数「x」も用意しておく。

・「for (p, s1) in T(s, pi[s]):」について、「p」はエピソードTで得られる「そのActionを起こす確率($\pi(a|s)$)」で、「s1」は「遷移先のState(after_state)」である。これらを使ってベルマン方程式(Chapter2の公式参照)で$V(s)$を計算する。これを「x」に代入する。

・この$V(s)$と$v(s)$を使った上記の式で「$\delta$」を計算し、閾値「$\epsilon$」を下回ったら価値関数の近似値「V」を返す。・実行部分を見てみると、「policy_evaluation()」の「v」部分に当たるVと、引数で渡すpiを定義している。関数を適用した結果、StateAの価値関数とStateBの価値関数がそれぞれ算出されている。

方策反復

・前項の価値評価によって算出された「$V^\pi(s)$」において、greedy手法をとるような方策を「$\pi'$」とすると、「$V^\pi(s)$ < $V^{\pi'}(s)$」となることが知られており、これを価値改善という。

・この価値改善と価値評価を繰り返すことで、最適価値関数を導出することができる。このことを方策反復という。

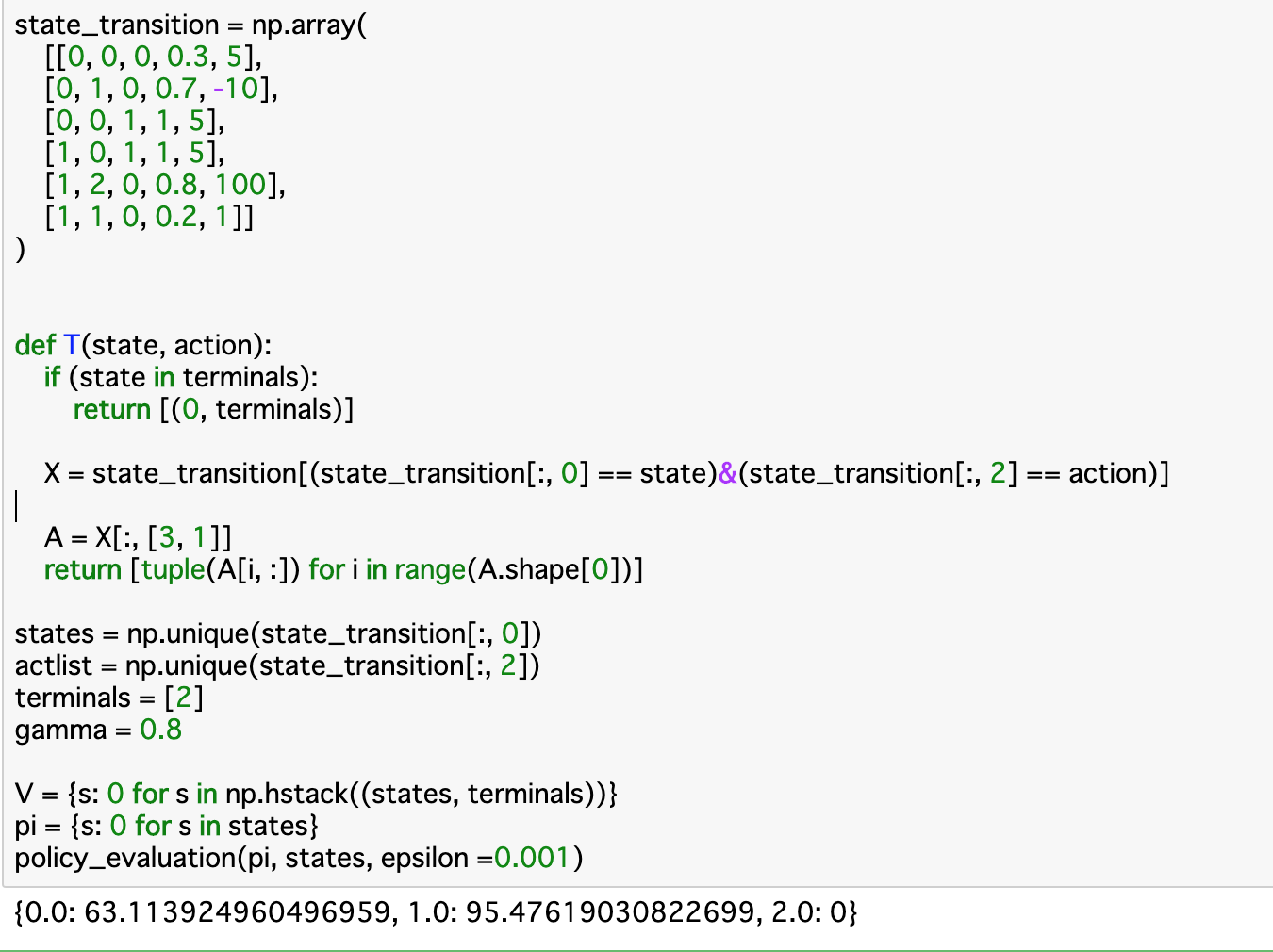

・価値改善を行う関数「policy_iteration()」のコードは以下のようになる。・上記コードについて、まずは価値関数Vと方策piを初期化する。これを行なったら、Vについて、Chapter2で作成した関数「policy_evaluation()」で方策評価を行う。同時に、「policy_flag=True」とする。

・各状態sについて、更新したVを使ってゲルマン方程式で方策piを算出し、これに従ってactionをソートする。そして、方策が被ってなければpiにactionを格納してループを継続する。これが終了したら方策piを返す。・方策反復関数「policy_iteration()」は方策piを返すので、この実行結果は「StateAの時ActionXを取り、StateBの時ActionXをとる」という方策を表している。

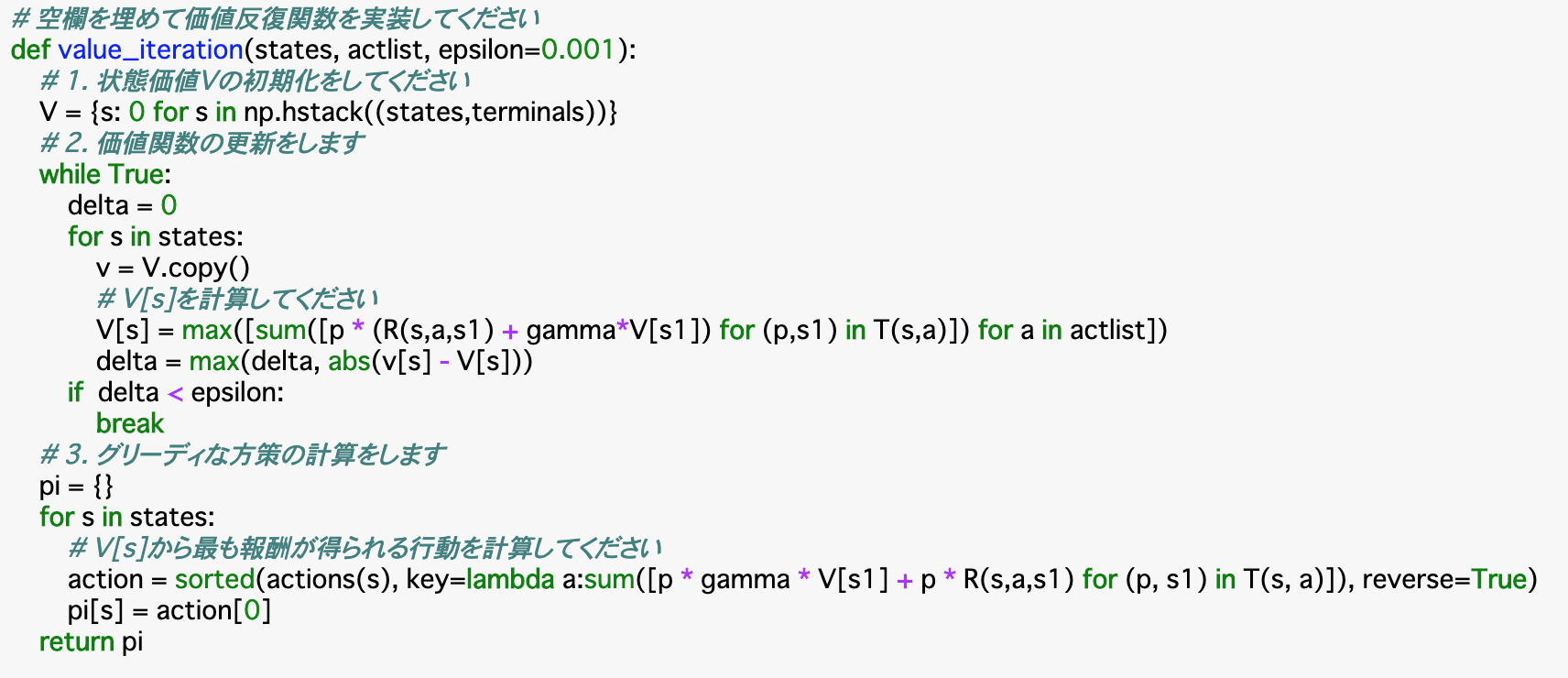

価値反復

・前項の方策反復は、方策piを計算するために毎回全ての状態について価値関数を計算し直すことを複数回おこなわなければならず、状態が増えるほど計算量も多くなってしまう。これを解決するのが「価値反復」という手法である。

・価値反復では、価値vを計算するために各状態sについて、価値関数を直接求めて更新する手法を取るので、価値関数の計算は一度で済む。

・以下は価値反復関数「value_iteration()」のコードである。・この関数について、まずは状態価値Vを今までと同様に初期化する。方策反復と違って方策piは考慮されないので、piの初期化を行う必要はない。次に、各行動について、方策評価を行って計算される$V(s)$の最大値を更新する。

・最後に、この$V(s)$から最も報酬が得られる行動を計算し、方策「pi」として返す。この時の最も報酬が得られる行動は前項の方策反復の時と同じように計算できる。TD手法

TD手法とは

・以上の手法は動的計画法であり、状態遷移確率Pがあらかじめわかっていければならない。逆に、状態遷移確率がわかっていない時はChapter1で学んだように、実際に集めた報酬からこれを推定していく必要がある。

・この推定方法として「TD手法」というものがある。TimeDifferanceの略で、最終結果を見ずに現在の推定値を利用して次の推定値を更新するという方法で行われる。

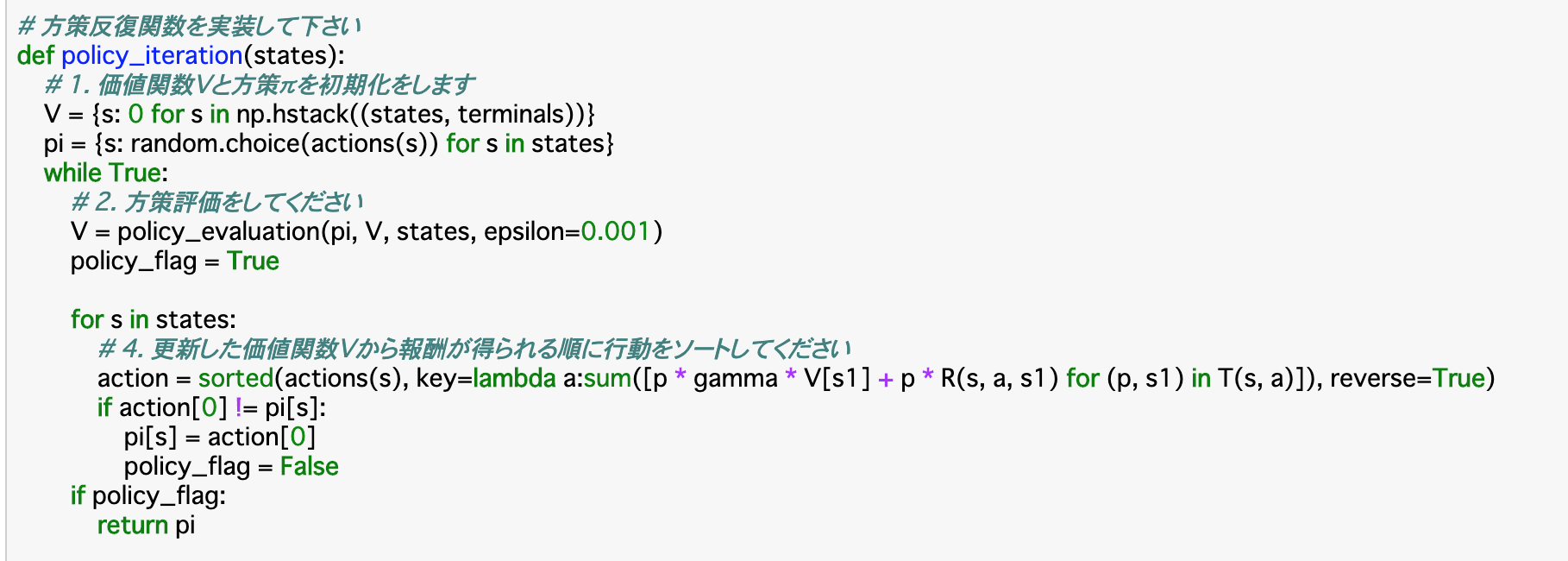

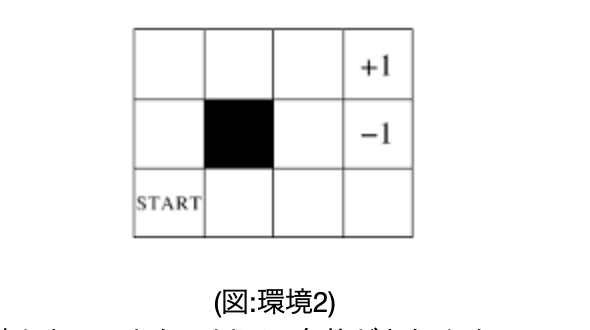

・TD法には、「Sarsa」「Q-learning」_といった手法がある。・開始地点は図の「start」のマス、終点は「+1」または「-1」のマス、黒いマスは遷移不可で、隣のマスの上下左右に動くことができる。また、8割の確率で、選択した通りに遷移することができるが、1割で選択した向きの90度時計回りに遷移し、残り1割で反時計回りに遷移する。報酬は、終点のマスはその点数、それ以外のマスは「-0.04」であるとする。

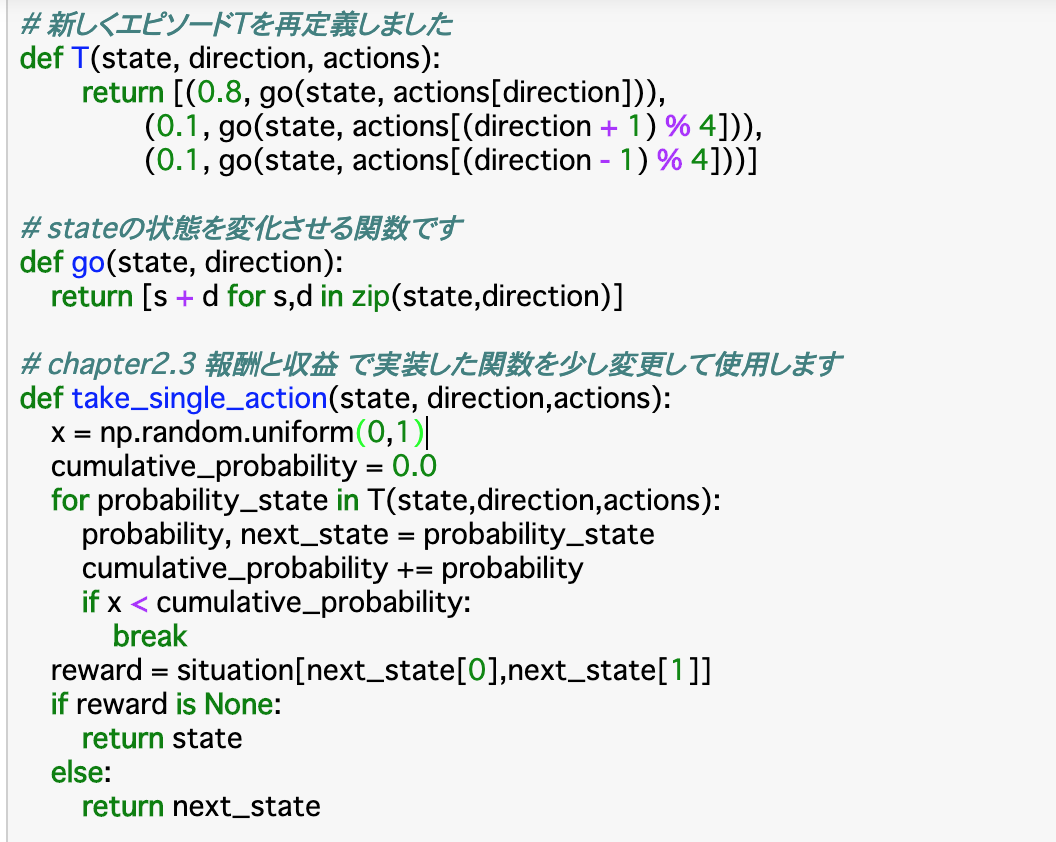

・以下のコードは、スタート地点から「上に二つ、右に三つ」進もうとした時の位置を出力する関数である。・新しい環境を使うので、まずはそれを定義する。エピソードを定義する関数「T()」は、「take_single_action()」で使用するため、0列目がprobabilily,1列目がnext_stateの配列を返すように定義する。また、next_stateの状態を変化させるため、stateとdirectionから移動先を定義する「go()」も作成する。

・遷移確率に基づいて次の状態を決定する関数である「take_single_action()」はここでも使用する。上記「T()」で定義した「遷移確率」がxを越えるまで「次の状態」を更新し、更新が終了した時点での報酬を設定する。

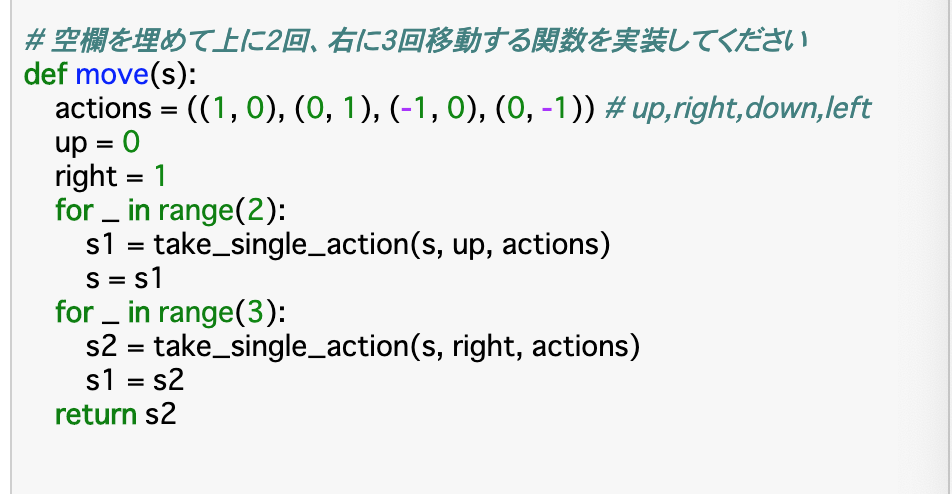

・最後に、実際に「今いるstateから上に2回右に3回」移動する関数「move()」を作成する。actionsとして、0列目が上下の動き、1列目が左右の動きを定義し、0列目について2回take_single_actionで移動し、同様に1列目について3回移動してstateを更新する。・環境についてはそれぞれのマスを定義している。初期地と終点も定義し、move()を使うことで移動後のstateがわかる。

Sarsa

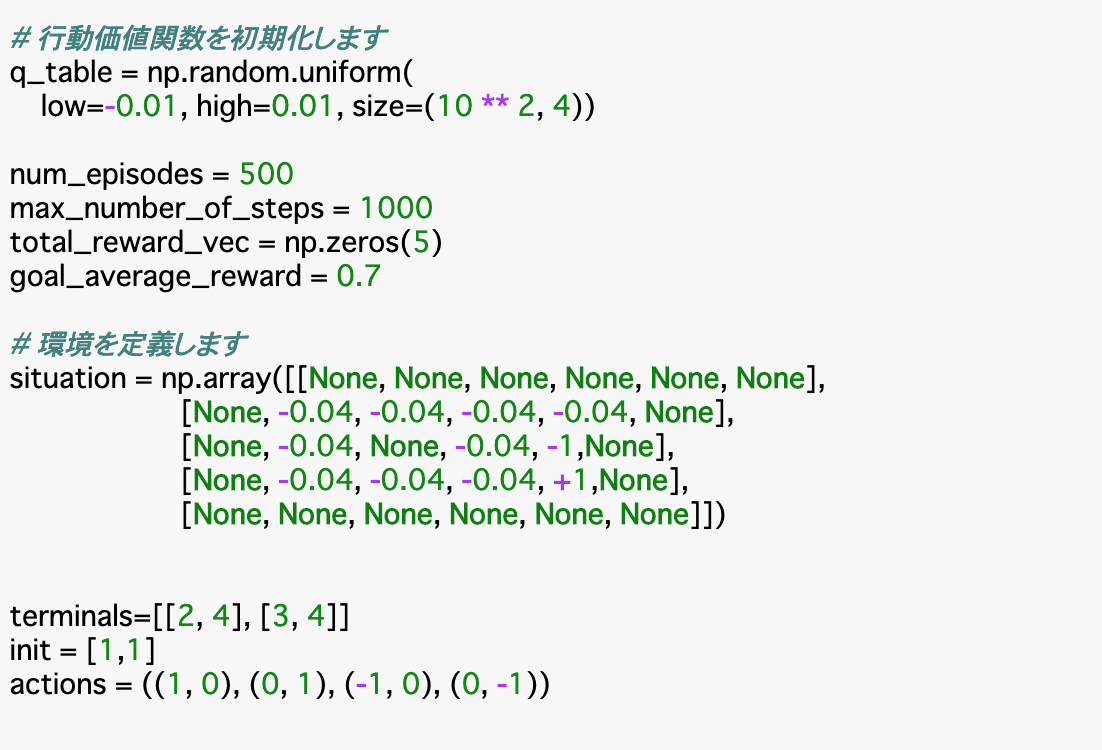

・SarsaはTD手法の一つで、ベルマン方程式を試行錯誤しながら解いていくものである。価値反復などでは$V(s)$を使っていたが、ここでは行動価値関数$Q(s,a)$を使用する。このQ関数は[全ての状態×全ての行動]の配列で表す。

・この時の「全ての状態」について、環境2では、取りうる状態は11通り、「全ての行動」は上下左右の4通りである。よってQ関数は11×4の配列にしたいのだが、状態は座標で表されるため、これをうまく表現できない。よって、状態の部分は「x座標×10 + y座標×1」で対応させる。・「get_action()」は、後で定義するQ関数(q_table)の最大値によって行動を決定する関数である。この時渡される「t_state」は、先述した「座標を変換したstate」である。

・「take_single_action()」は今までのものと用途は同じだが、返される値として、rewardが設定されていない場合、すなわち行動先が壁や障害物で移動できない時は、その場に止まると言う意味で、状態「state」とreward「-0.04」を返し、rewardが設定されているマスにいるときは「next_state」とそのrewardを返す。

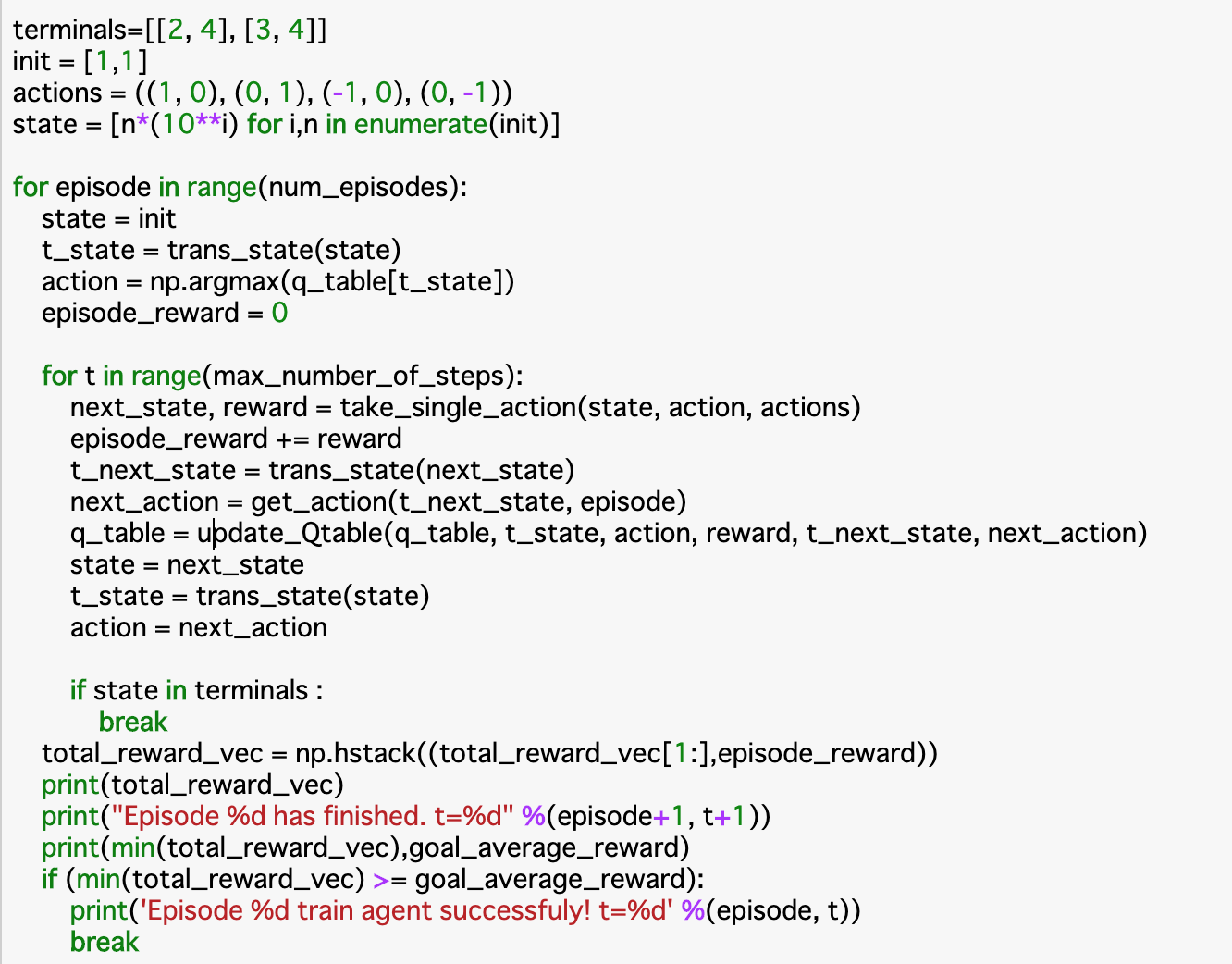

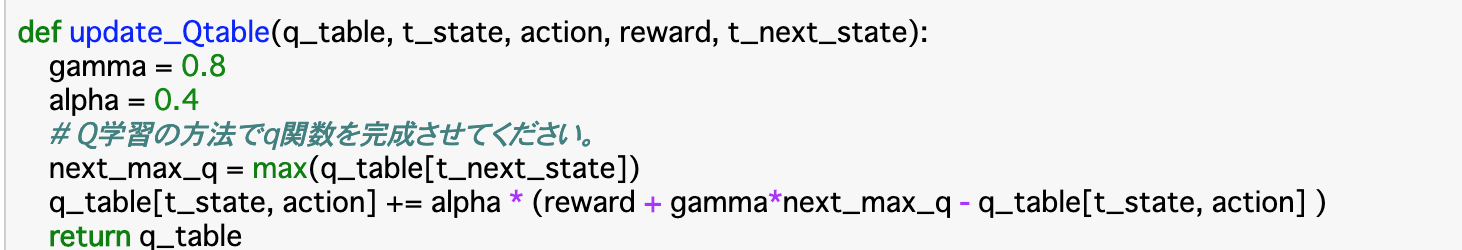

・「update_qtable()」は実際に行動価値関数Qを算出し、更新する関数である。この更新の時に使われる公式は以下である。

$$Q(s,a) += \alpha[r + \gamma Q(s',a') - Q(s,a)]$$・この$\alpha$は学習率であり、事前に設定しておく必要がある。今回は「0.4」で設定する。また、割引率$\gamma$は「0.8」とする。また、この時渡される状態も、「座標を変換したstate」とする。計算自体は公式通りに行えば良い。

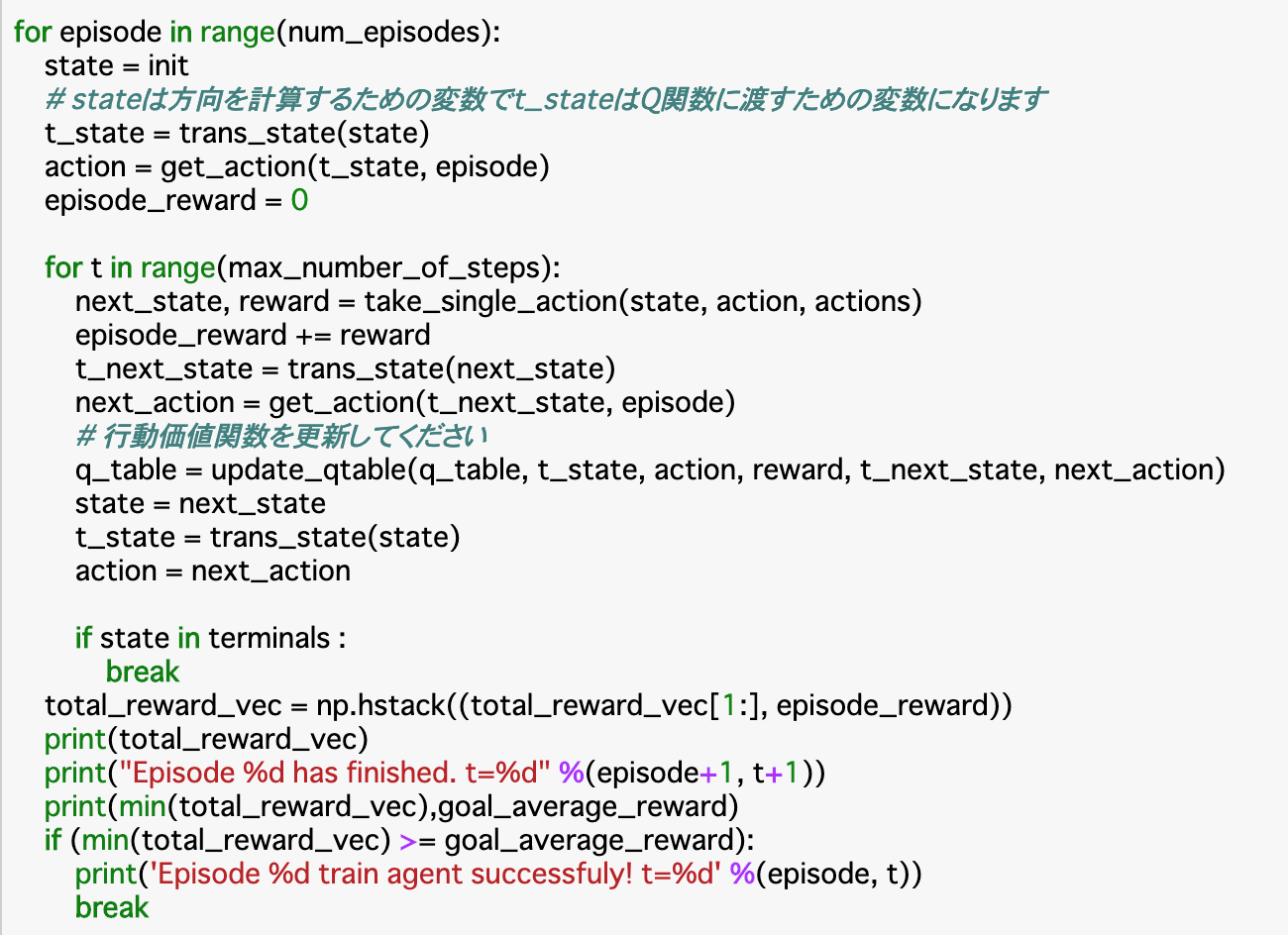

・最後に、状態「state」を「座標を変換したstate」にする「trans_state()」関数を作成する。・Sarsaを実行するにあたり、まずは行動価値関数Qを初期化する。今回はエピソード数は500、時間ステップは最大1000回とし、またエピソードの終了条件として「5回連続で平均報酬が0.7以上」を設定するため、これを管理する配列も準備する。環境などは前項と同じ。

・次に、500回の各エピソードについて、(終了条件を満たすまで)以降の全てを繰り返す。

・まずはstateを初期化する。これに基づいて、Q関数に渡す「t_state」、行動「action」を計算する。それぞれ「trans_state()」「get_action()」関数を使用する。

・次に、エピソード中の各時間ステップについて「take_single_action()」で、行動aを行なった場合の次の状態s'と報酬rを取得し、報酬を累積していく。また、状態s'についてもQ関数に渡す「t_next_state」、行動「next_action」を計算する。

・これらを「update_qtable()」に渡して、行動価値関数を更新する。また、次の時間ステップに行くためにstateやactionも更新する。

・最終的に終点についたら、そのエピソードは終了し、次のエピソードに移動する。移動する前に、エピソード終了条件である報酬について「total_reward_vec」を更新し、それを出力する。同様に、終了したエピソードの番号と、それが何ステップで終了したかを出力する。

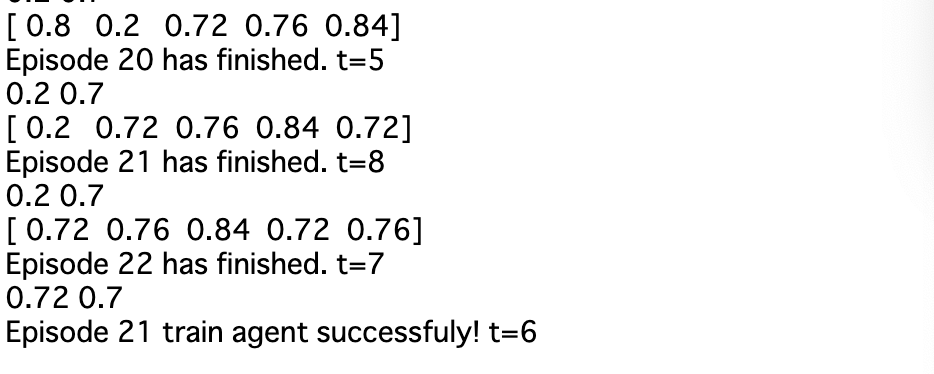

・もしこの「total_reward_vec」の最小値が0.7を超えたらエピソードの繰り返しも終了する。・実行結果をみてみると、報酬が「0.2」であったエピソードが直近5エピソードから除外され、全ての報酬が0.7を超えたエピソード21+1で終了している。

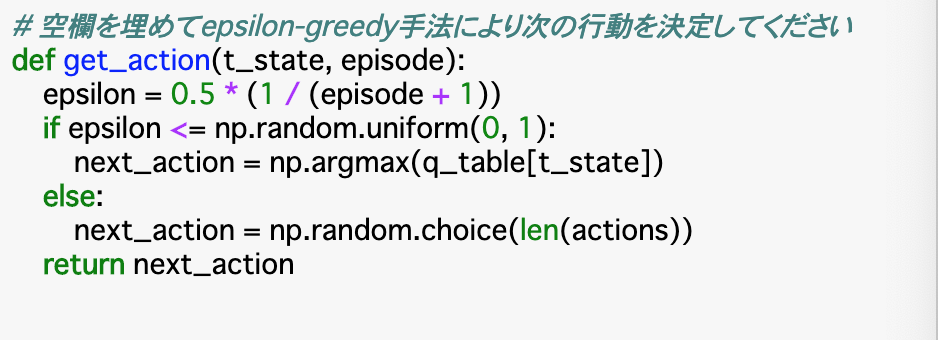

Sarsaでのε-greedy手法の実装

・前項の手法では、Q関数の最大値のみを選択していたが、これではより優れた手法を見逃す恐れがある。これを避けるために、ε-greedy手法を使って新しい手法を探索していく。

・Chapter1でもε-greedy手法を使ったが、少し変えて使用する。今回は、「episodeが早いうちはεを大きくして探索の割合を増やし、episodeが進むにつれてεの値を小さくして探索を狭めていく」というやり方を使う。式としては以下のものを使う。