- 投稿日:2020-11-13T23:25:26+09:00

【OpenCV/Python】OpenCVで細胞の画像解析をやってみた

はじめに

仕事柄、細胞の画像を撮影することが多く、細胞画像をPython版OpenCVで解析してみた。

備忘録的な意味も込めて。

今回は、培養容器接着面を培養細胞が覆った割合(細胞占有面積率、あるいはコンフルエンシー)、いわゆる「細胞のコンフル」を求めてみる。

要するに、顕微鏡画像の中の細胞の占有率を、画像解析によって数値化する。

ご意見や、もっとこうしたほうがいいなどあればコメントお願いします。

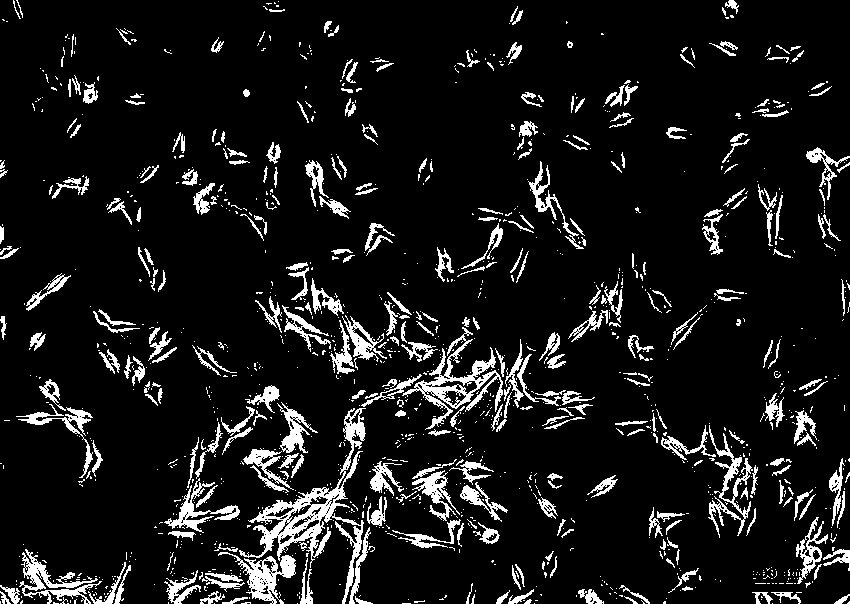

使用する画像

間葉系幹細胞(MSC)と呼ばれる細胞の顕微鏡写真。

ぱっと見、コンフル(画像中の細胞の占有率)は30~40%程度というところでしょうか。

必要なパッケージ

Pythonを使って画像解析するため、OpenCVライブラリを読み込む。

それと、NumPyも読み込んでおく。

# ライブラリ import cv2 import numpy as np画像の読み込みとグレースケール化

imread()関数で画像データをカラーで読み込んで、cvtColor()関数でグレースケール化する。

cvtColor()関数の第一引数は入力画像(カラー画像)。

imread()関数で取得したデータは BGR 形式なので、cv2.COLOR_BGR2GRAYを第2引数に指定する。# カラー画像の読み込み img = cv2.imread('cell.jpg', 1) # グレースケール化 img_gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)画像を二値化する

画像を二値化する。

つまり、画素値がしきい値より大きければある値(白)を割り当て、そうでなければ別の値(黒)を割り当てる。

二値化には、いろいろな方法があるらしいが、「大津の二値化」というものを使ってみた。

二値化するにはthreshold()関数を使う。

threshold()関数の第1引数は入力画像でグレースケール画像でないといけない。

第2引数はしきい値で、画素値を識別するために使う。

第3引数は最大値でしきい値以上の値を持つ画素に対して割り当てられる値。

前述の通り、OpenCVはいくつかのしきい値処理の方法があり、第4引数にて指定する。

今回は「大津の二値化」を使うため、cv2.THRESH_BINARY+cv2.THRESH_OTSUとする。# 大津の二値化 ret,th = cv2.threshold(img_gray,0,255,cv2.THRESH_BINARY+cv2.THRESH_OTSU)threshold()関数は2つの戻り値を返す。

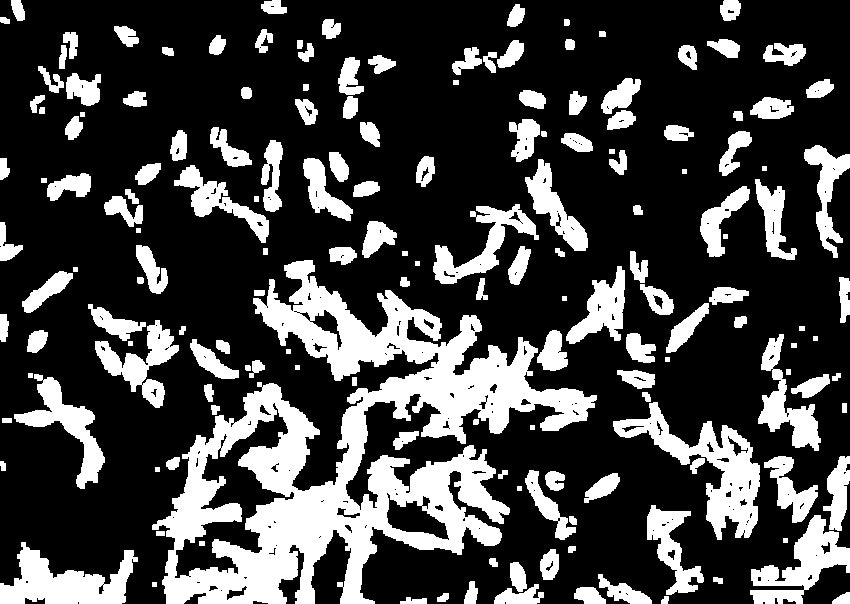

2つ目の戻り値thが、二値化画像となる。モルフォロジー変換(膨張)

画像のノイズを除去するためにモルフォロジー変換(膨張)を行う。

カーネルのサイズ(今回は5×5サイズ)に依存して物体の境界付近の全画素が黒(0)から白(1)になって消える。

カーネル内に画素値が ‘1’ の画素が一つでも含まれれば、出力画像の注目画素の画素値を ‘1’ になる。# カーネルの設定 kernel = np.ones((5,5),np.uint8) # モルフォロジー変換(膨張) th_dilation = cv2.dilate(th,kernel,iterations = 1)細胞内の黒い領域を白い領域に変換できた。

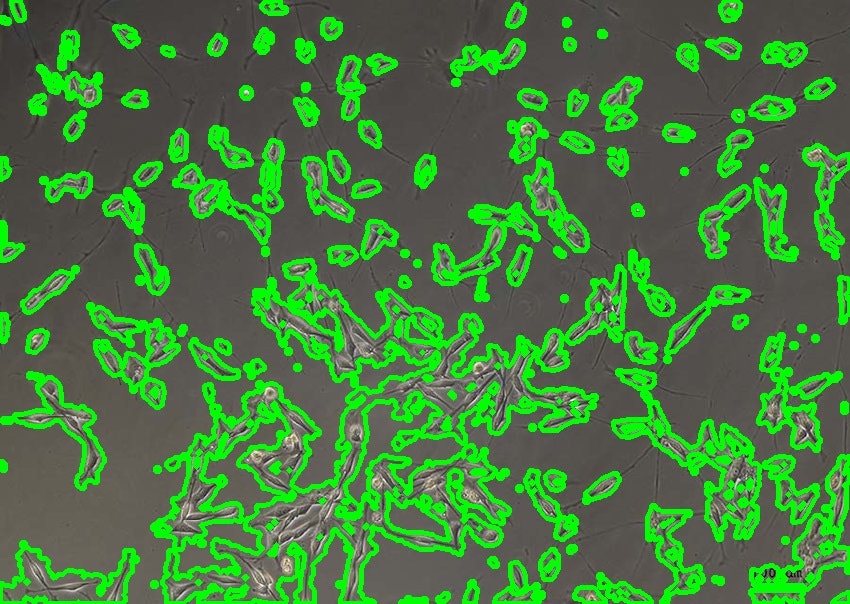

輪郭抽出

モルフォロジー変換によりノイズを除去した画像をもとに輪郭を抽出する。

輪郭を抽出するにはfindContours()関数を使う。

findContours()関数の第1引数は輪郭抽出に使う画像。

第2引数は抽出モード、第3引数は輪郭の近似方法を指定する。findContours()関数の戻り値である

contoursは各輪郭の座標データがNumpyのarray形式で収められている。

contoursを使って、drawContours()関数により元画像に輪郭を描画する。全輪郭を描画する時はdrawContours()関数の第3引数を

-1に指定する。# 輪郭抽出 contours, hierarchy = cv2.findContours(th_dilation, cv2.RETR_LIST, cv2.CHAIN_APPROX_NONE) # 輪郭を元画像に描画 img_contour = cv2.drawContours(img, contours, -1, (0, 255, 0), 3)白黒面積の計算

.sizeで全体の画素数を取得する。countNonZero()関数で白領域、つまり細胞領域の画素数を取得する。

全体の画素数 - 白領域を計算し、黒領域(細胞以外の領域)の画素数を取得する。

最後にそれぞれの割合を表示する。

# 全体の画素数 whole_area = th_dilation.size # 白部分の画素数 white_area = cv2.countNonZero(th_dilation) # 黒部分の画素数 black_area = whole_area - white_area # それぞれの割合を表示 print('White_Area =' + str(white_area / whole_area * 100) + ' %') print('Black_Area =' + str(black_area / whole_area * 100) + ' %')結果

White_Area =26.266264121542658 % Black_Area =73.73373587845734 %細胞のコンフルは大体30%という結果となった。

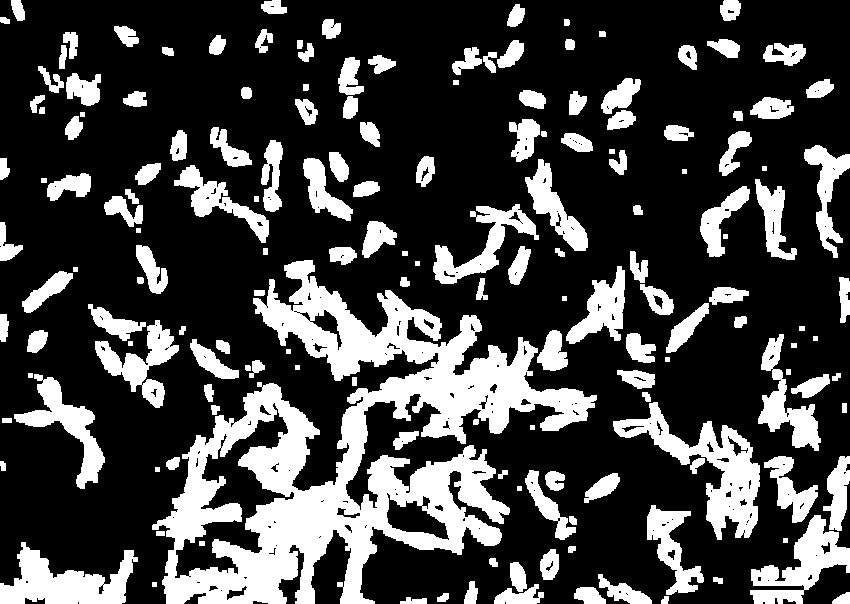

画像の表示

最後に、輪郭を加えた元の画像と輪郭抽出に用いた画像を表示する。

# 画像の表示 cv2.imshow('img', img) cv2.imshow('th_dilation', th_dilation) cv2.waitKey(0) cv2.destroyAllWindows()結果

最終的なスクリプト

# ライブラリ import cv2 import numpy as np # カラー画像の読み込み img = cv2.imread('cell.jpg', 1) # グレースケール化 img_gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY) # 大津の二値化 ret,th = cv2.threshold(img_gray,0,255,cv2.THRESH_BINARY+cv2.THRESH_OTSU) # カーネルの設定 kernel = np.ones((5,5),np.uint8) # モルフォロジー変換(膨張) th_dilation = cv2.dilate(th,kernel,iterations = 1) # 輪郭抽出 contours, hierarchy = cv2.findContours(th_dilation, cv2.RETR_LIST, cv2.CHAIN_APPROX_NONE) # 輪郭を元画像に描画 img_contour = cv2.drawContours(img, contours, -1, (0, 255, 0), 3) # 全体の画素数 whole_area = th_dilation.size # 白領域の画素数 white_area = cv2.countNonZero(th_dilation) # 黒領域の画素数 black_area = whole_area - white_area # それぞれの割合を表示 print('White_Area =' + str(white_area / whole_area * 100) + ' %') print('Black_Area =' + str(black_area / whole_area * 100) + ' %') # 画像の表示 cv2.imshow('img', img) cv2.imshow('th_dilation', th_dilation) cv2.waitKey(0) cv2.destroyAllWindows()

- 投稿日:2020-11-13T23:23:14+09:00

yukicoder contest 274 参戦記

yukicoder contest 274 参戦記

A 1285 ゴミ捨て

小さい順でも大きい順でもいいので一つづつ重ねれるかをチェックして行けばいいだけ.

from heapq import heappush, heapreplace N, *A = map(int, open(0).read().split()) A.sort() q = [A[0]] for a in A[1:]: if a <= q[0] + 1: heappush(q, a) else: heapreplace(q, a) print(len(q))B 1286 Stone Skipping

1回も跳ねないと x、1回跳ねると 3/2 * x、2回跳ねると 7/4 * x、3回跳ねると 15/8 * x、n回跳ねると (2n+1-1)/2n * x となる. D≦1018 なので60回も跳ねるとそれ以降は飛距離が伸びなくなる. なので、60回、59回、……、1回跳ねた場合の答えがあるかを調べていけば良い. 切り捨ての影響があるので、適当に前後±100くらいをチェックしたら AC した.

D = int(input()) def f(x): result = 0 while x != 0: result += x x //= 2 if result >= D: break return result for i in range(60, 0, -1): t = D * (2 ** (i - 1)) // (2 ** i - 1) for j in range(-100, 100): if t + j < 0: continue if f(t + j) == D: print(t + j) exit()

- 投稿日:2020-11-13T22:47:42+09:00

ALDA実行メモ

https://github.com/ZJULearning/ALDA

これを実行。データは下記。

https://github.com/notfolder/svhnsplitしたので、catで結合して使う。

pip freeze結果

asn1crypto==0.24.0 certifi==2018.1.18 chardet==3.0.4 cryptography==2.1.4 dataclasses==0.7 future==0.18.2 idna==2.6 imageio==2.1.2 keyring==10.6.0 keyrings.alt==3.0 numpy==1.14.6 Pillow==5.3.0 protobuf==3.13.0 pycrypto==2.6.1 pygobject==3.26.1 pyxdg==0.25 requests==2.18.4 SecretStorage==2.3.1 six==1.11.0 ssh-import-id==5.7 tensorboardX==1.4 torch==1.7.0 torchsummary==1.5.1 torchvision==0.8.1 tqdm==4.26.0 typing-extensions==3.7.4.3 urllib3==1.22Dockerfileはこれ。vscode-server.tgzは無くてよし

FROM nvidia/cuda:10.0-base-ubuntu18.04 # sshサーバをインストールします RUN apt-get update && apt-get install -y openssh-server # これが無いとsshdが起動しないっぽい RUN mkdir /var/run/sshd # sshのrootでのアクセスを許可します。ただし、パスワードでのアクセスは無効 RUN sed -i 's/#PermitRootLogin prohibit-password/PermitRootLogin prohibit-password/' /etc/ssh/sshd_config # ホスト側にある公開鍵をイメージ側に登録します COPY id_rsa.pub /root/.ssh/authorized_keys # add sudo user RUN groupadd -g 1000 notfolder && \ useradd -g notfolder -G sudo -m -s /bin/bash notfolder RUN echo 'Defaults visiblepw' >> /etc/sudoers RUN echo 'notfolder ALL=(ALL) NOPASSWD:ALL' >> /etc/sudoers #COPY id_rsa.pub /home/notfolder/.ssh/authorized_keys RUN mkdir -p /home/notfolder/.ssh COPY id_rsa.pub /home/notfolder/.ssh/authorized_keys RUN chown 1000:1000 -R /home/notfolder RUN chmod 700 /home/notfolder/.ssh RUN apt-get update && apt-get install -y python3 && \ apt-get install -y python3-pip && \ update-alternatives --install /usr/bin/python python /usr/bin/python3 0 && \ update-alternatives --set python /usr/bin/python3 && \ update-alternatives --install /usr/bin/pip pip /usr/bin/pip3 0 && \ update-alternatives --set pip /usr/bin/pip3 && \ pip install --upgrade pip COPY vscode-server.tgz /tmp/ RUN tar -zxf /tmp/vscode-server.tgz -C /home/notfolder/ COPY requirements.txt /tmp/ RUN pip install -r /tmp/requirements.txt EXPOSE 22 CMD ["/usr/sbin/sshd", "-D"]nvidia-smiは下記。

$ nvidia-smi Fri Nov 13 22:46:44 2020 +-----------------------------------------------------------------------------+ | NVIDIA-SMI 450.80.02 Driver Version: 450.80.02 CUDA Version: 11.0 | |-------------------------------+----------------------+----------------------+ | GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC | | Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. | | | | MIG M. | |===============================+======================+======================| | 0 GeForce RTX 2070 Off | 00000000:04:00.0 Off | N/A | | 29% 35C P0 20W / 175W | 0MiB / 7982MiB | 0% Default | | | | N/A | +-------------------------------+----------------------+----------------------+ +-----------------------------------------------------------------------------+ | Processes: | | GPU GI CI PID Type Process name GPU Memory | | ID ID Usage | |=============================================================================| | No running processes found | +-----------------------------------------------------------------------------+

- 投稿日:2020-11-13T21:42:02+09:00

【1】UbuntuにAnacondaで構築するTensorFlow-GPU環境構築〜GPUスペック確認編〜

TensorFlowのGPU版(tensorflow-gpu)を動かすために必要なこととは?

- Deep Learningを行う計算力(compute capability)のある比較的新しいGPU(nVidia社製)を搭載していること?今ここ

- GPUの適切なドライバが入っていて、使用可能な状態になっていること

- tensorflow-gpuやGPUのドライバ(CUDA)、Deep Learning用のライブラリ(cuDNN)をインストールする環境を作るため、Anacondaがインストールされていること

- Pythonや必要なライブラリがバージョンの互換性を持っていること

この記事のゴール

tensorflow-gpuを動かすことができるGPUが搭載されているのかを確認し、これ以降のステップに進めるかどうかを判断する。

クリアするべき二つの条件

そのためには以下の二つの条件を満たしているかを確認していきます。

条件1: nVidia社製のGPUを搭載していること

条件2: コンピュータのGPUがTensorFlowの要求する計算力(compute capability)を満たすこと条件1の確認手順

条件1から確認していく。そもそも、nVidia社製のGPUが搭載されているかを確認するので、次のようにコマンドを実行する。結果、このコンピュータに搭載されているGPUはnVidia社製のQuadro K2200だと判明(条件1をクリア)。

$ lspci | grep -i nvidia 02:00.0 VGA compatible controller: NVIDIA Corporation GM107GL [Quadro K2200] (rev a2) 02:00.1 Audio device: NVIDIA Corporation Device 0fbc (rev a1)条件2の確認手順

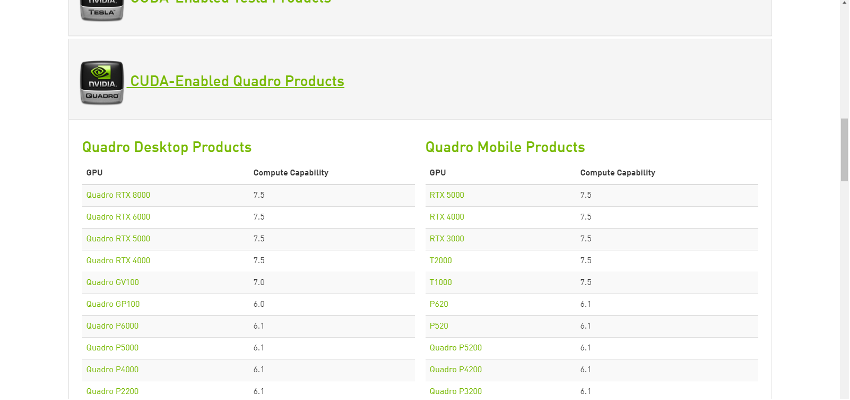

次に条件2の確認に入る。以下のページからcompute capabilityを見ておく(tensorflow-gpuを動かすにはcompute capability3.0以上が必要)。

先のコマンドでGPUはQuadroシリーズの製品だと分かったので、CUDA-Enabled Quadro Productsのボタンをクリックして表を表示させる。

該当の行を探す。

結果、Quadro K2200はcompute capabilityが3.0であることが判明(条件2をクリア)。

もしcompute capabilityが不足していたら

これ以降の環境構築をこなせたとしてもGPUでの計算はできません。そのときは本当にGPUを用いなくてはならないほどの計算なのかを再検討しましょう。必要ならcompute capabilityを満たすGPUを購入しましょう。

二つの条件がクリアできたら

環境構築に取り掛かっていきます。次の記事ではGPUのドライバーをインストールしてきます。

- 投稿日:2020-11-13T21:39:13+09:00

AxisのPTZカメラをROS上で制御してみた

経緯

AxisのPTZカメラをROS上で動かす機会があったので、その手順をまとめてみました。PTZ(パンチルトズーム)カメラとは、パン(左右)、チルト(上下)、ズーム(拡大)の制御ができるカメラのことです。

axis_cameraについて

最初は、PTZも含めたカメラ制御ができるpython-onvifを使おうとしたのですが、Axisのカメラに対応していなかったので、他の方法を探すことにしました。そこで見つけたのがaxis_cameraでした。axis_cameraはAxisのカメラ制御用のROSパッケージです。とても便利ですが、python2で書かれているので注意が必要です。近いうちに自分でpython3に書き換えたものを作って、また記事にしようと思います。

環境

- AXIS M5525-E PTZ Network Camera

- Ubuntu 18.04

- ROS Melodic

- python2.7

手順

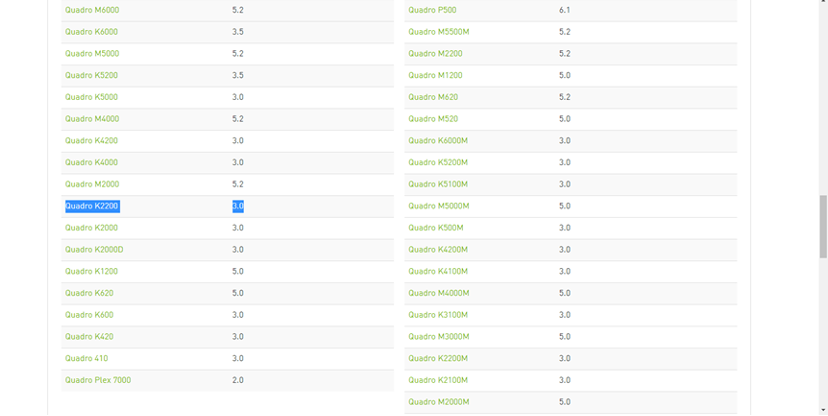

まず、準備としてaxisのデフォルトの権限がrootなので、ptz制御できるようにanonymousに変えておきます。Axisのカメラ設定画面の右下のSettings->System->Usersといくと下のようなページに行くので、Anonymous usersをONにします。

次にgithubからソースコードを落としてきて、ROSを動かしていきます。

$ git clone https://github.com/ros-drivers/axis_camera.git $ cd axis_camera $ roscore別のターミナルを開いて、下のコマンドを実行します。

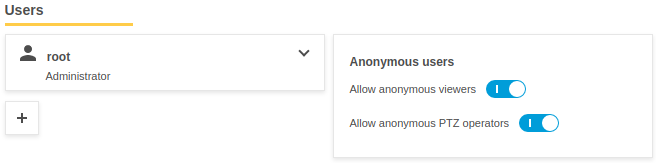

$ rosrun axis_camera axis_ptz.py _hostname:=IP_ADDRESS_OF_YOUR_CAMERAaxis_cameraはROSのDynamic Reconfigureを使ってGUI上でPTZ制御ができるようになっています。

別のターミナルを開き、下のコマンドを実行します。$ rosrun rqt_reconfigure rqt_reconfigureすると、下のようなGUIが出現します。それぞれのスライドバーを動かすことで、PTZ制御ができます。

デフォルトだと、tiltが動作しなかったので、PTZ.cfgの中のtiltの設定値を変更しました。それぞれの項目はgen.add()の後ろの3つに初期値、最小値、最大値の順で並んでいます。

#!/usr/bin/env python PACKAGE = "axis_camera" from dynamic_reconfigure.parameter_generator_catkin import * gen = ParameterGenerator() #gen.add("speed_control", bool_t, 0, "Speed control (true) or absolute position control (false)", False) gen.add("autofocus", bool_t, 0, "Autofocus", True) gen.add("pan", double_t, 0, "Pan value in degrees (or percent in absolute mode)", 0, -180, 180) // tiltの値を-45,-90,0から0,0,90に変えている gen.add("tilt", double_t, 0, "Tilt value in degrees (or percent in absolute mode)", 0, 0, 90) gen.add("zoom", double_t, 0, "Zoom value", 1, 1, 9999) gen.add("focus", double_t, 0, "Focus", 1, 1, 9999) gen.add("brightness", double_t, 0, "Brightness", 1, 1, 9999) exit(gen.generate(PACKAGE, "axis_camera", "PTZ"))まとめ

Axisのカメラであれば、簡単にROS上で動かすことができました。PTZカメラは動かすだけでも楽しいので、是非買ってみてください!家での使い道はあんまり無いと思いますが(笑)。

参考文献

- 投稿日:2020-11-13T21:37:55+09:00

pythonのbool型は遅い

言いたいこと

競技プログラミングにおいてTrue/Falseをbool型で扱うのは遅いです。

int型を使いましょう。概要

何かフラグを用意して、それによって処理を分岐させることはよくあると思います。

f = 1とする人も

f = Trueとする人もいるかと思いますが、どちらも同じ事が起きると期待しますよね。

しかし、実際は実行速度に差がでます。

正確に言うと、真偽値の判定に差がは無く、書き換えで差が出ます。これは後ほど語ります。

実験

以下のコードで比較してみます。

実行環境はatcoderのコードテストでPyPy3(3.7.0)です。int.pyf = 1 for i in range(10**9): if f: f = 0 else: f = 1bool.pyf = True for i in range(10**9): if f: f = False else: f = True結果はこのようになりました。(複数回やってもだいたいこんな感じです)

コード 実行時間 メモリ int.py 2423 ms 25640 KB bool.py 7439 ms 25612 KB 思ったより差がデカくないですか!?

実行速度が厳しい問題だと、これだけでもTLEの危険が高まります。

(実際、これでABC182 Eでハマりました)考察

ということで、あくまでpythonで競技プログラミングをやる場合の話ですが、フラグを使いたい場合にはbool型ではなくint型を使うようにしましょう。

いろいろ実験してみましたが、速度の差に影響があるのは真偽値判定ではなく値の書き換えのようでした。

詳しい理屈はわかりませんが、int型の方が機械にとっては素直に扱いやすいといったところ?フラグとして使うからには書き換えが前提になるかと思いますので注意が必要です。

例えば途中でフラグを立てたらそれ以降立てっぱなしという場合であれば、速度に差は出ないはずです。

コロコロと立てたり折ったりする場合にはこんなつまらない理由でTLEしてしまうかもしれません。とくにこだわりがなければint型を使うことをおすすめします。

おまけ

strでもやってみました。

str.pya = "True" for i in range(10**9): if a == "True": a = "False" else: a = "True"結果は以下の通りです。さすがに一番遅いですね。

実行時間 メモリ 8183 ms 25612 KB

- 投稿日:2020-11-13T21:37:55+09:00

pypyのbool型は遅い

修正

最初「pythonのbool型は遅い」とのタイトルで公開しておりましたが、記事の内容が当てはまるのはpypyを使う場合のみであり、誤りでした。

誤った情報を流してしまい、申し訳ありません。言いたいこと

競技プログラミングでpypyを利用する時、True/Falseをbool型で扱うのは遅いです。

int型を使いましょう。概要

何かフラグを用意して、それによって処理を分岐させることはよくあると思います。

f = 1とする人も

f = Trueとする人もいるかと思いますが、どちらも同じ事が起きると期待しますよね。

しかし、実際は実行速度に差がでます。

正確に言うと、真偽値の判定に差がは無く、書き換えで差が出ます。これは後ほど語ります。

実験

以下のコードで比較してみます。

実行環境はatcoderのコードテストでPyPy3(3.7.0)です。int.pyf = 1 for i in range(10**9): if f: f = 0 else: f = 1bool.pyf = True for i in range(10**9): if f: f = False else: f = True結果はこのようになりました。(複数回やってもだいたいこんな感じです)

コード 実行時間 メモリ int.py 2423 ms 25640 KB bool.py 7439 ms 25612 KB 思ったより差がデカくないですか!?

実行速度が厳しい問題だと、これだけでもTLEの危険が高まります。

(実際、これでABC182 Eでハマりました)考察

ということで、あくまで競技プログラミングでpypyを使う場合の話ですが、フラグを使いたい場合にはbool型ではなくint型を使うようにしましょう。

いろいろ実験してみましたが、速度の差に影響があるのは真偽値判定ではなく値の書き換えのようでした。

フラグとして使うからには書き換えが前提になるかと思いますので注意が必要です。

例えば途中でフラグを立てたらそれ以降立てっぱなしという場合であれば、速度に差は出ないはずです。

コロコロと立てたり折ったりする場合にはこんなつまらない理由でTLEしてしまうかもしれません。とくにこだわりがなければint型を使うことをおすすめします。

おまけ

strでもやってみました。

str.pya = "True" for i in range(10**9): if a == "True": a = "False" else: a = "True"結果は以下の通りです。さすがに一番遅いですね。

実行時間 メモリ 8183 ms 25612 KB 追記

python3で実行した場合は誤差の範囲内でした。

@shiracums さん、ご指摘ありがとうございました。

- 投稿日:2020-11-13T21:20:46+09:00

[Blender×Python] マテリアルをマスターしよう!!

目次

0.マテリアルを追加する方法

1.ガラスのマテリアルをつくってみよう!!

2.メタリックをつくってみよう!!

3.テキストを追加しよう!!

4.英単語※今回は解説が少ないので、サンプルコードだけでまとめてはいません。

0.マテリアルを追加する方法

0-1.マテリアルを追加していく手順

①新しいマテリアルをつくる

②ノードを使えるようにする

③オブジェクトを追加する

④ノードの値を設定する

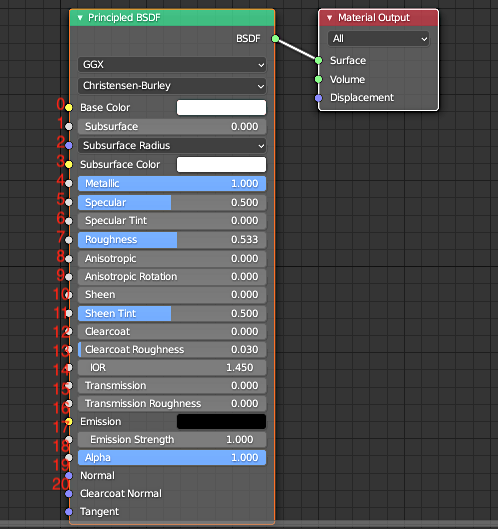

⑤オブジェクトにマテリアルを適応する0-2.Principled BSDFの中身

◯それぞれの項目は0から順番に数字が割り当てられています。

Base Color→0

Subsurface→1

:

Metallic→4

:

Roughness→7

:

Transmission→15のようになっています。

◯これを利用して

nodes["Principled BSDF"].inputs[0]のようにして指定していきます。1.ガラスのマテリアルをつくってみよう!!

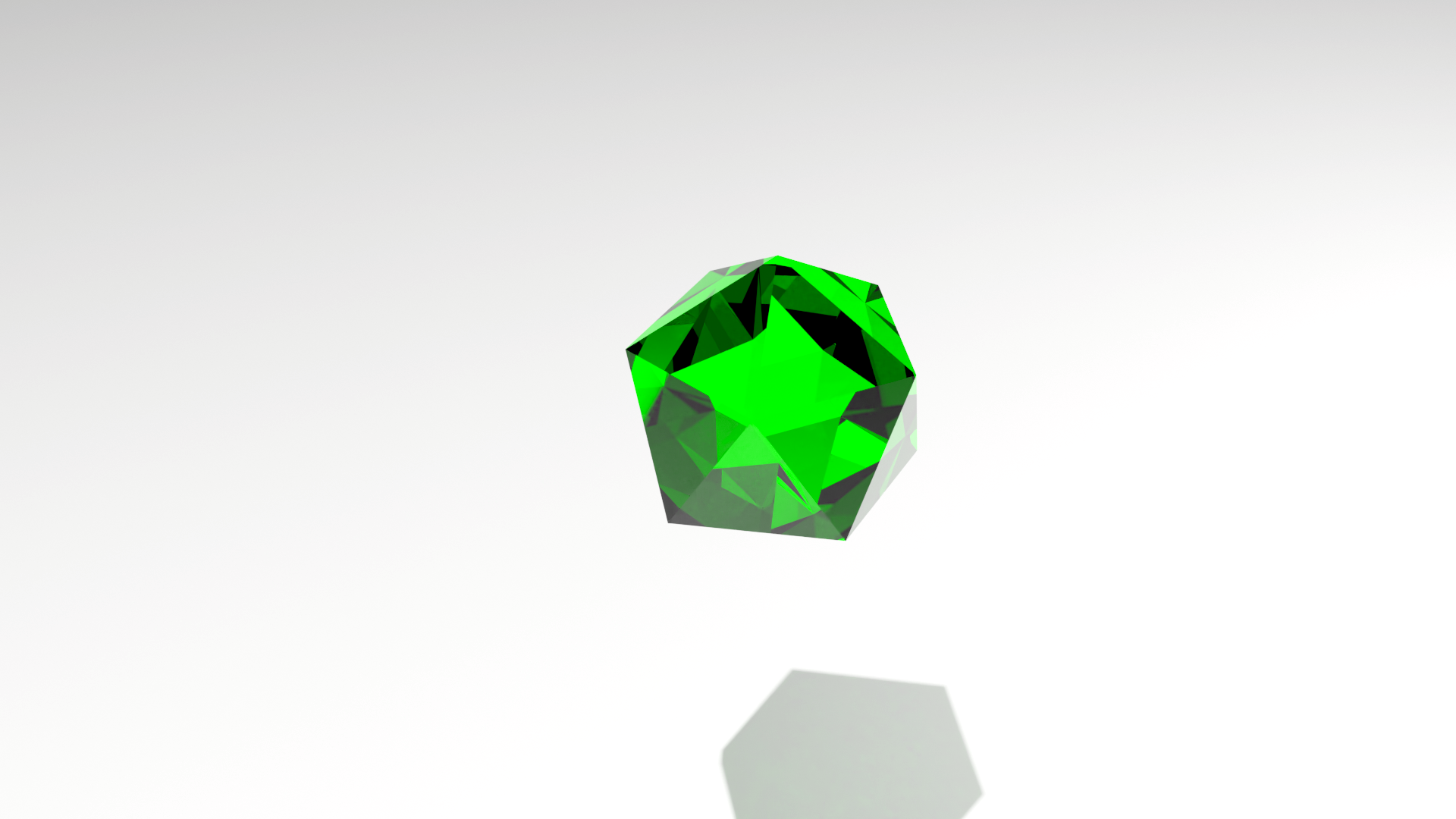

◯シンプルなガラスのico_sphereを作るプログラム

import bpy #新しいマテリアルをつくる material_glass = bpy.data.materials.new('Green') #ノードを使えるようにする material_glass.use_nodes = True #オブジェクトを追加する bpy.ops.mesh.primitive_ico_sphere_add(subdivisions=1, enter_editmode=False, align='WORLD', location=(0, 0, 0), scale=(1, 1, 1)) #ノードの値を設定していく #変数p_BSDFをつくって書く量を減らす p_BSDF = material_glass.node_tree.nodes["Principled BSDF"] #0→BaseColor/7→roughness(=粗さ)/15→transmission(=伝播) #default_value = (R, G, B, A) p_BSDF.inputs[0].default_value = (0, 1, 0, 1) p_BSDF.inputs[7].default_value = 0 p_BSDF.inputs[15].default_value = 1 #オブジェクトにマテリアルの要素を追加する bpy.context.object.data.materials.append(material_glass)

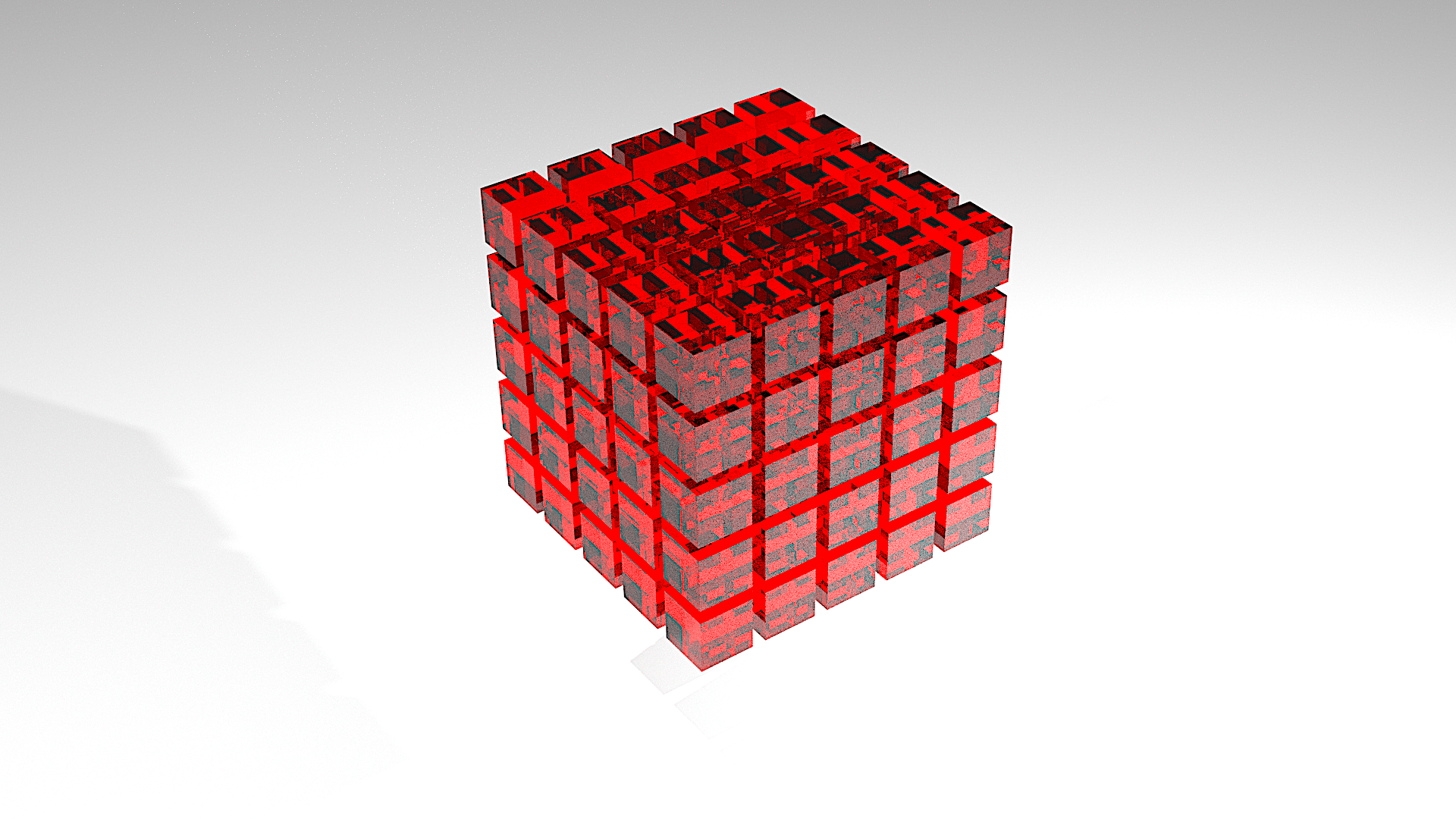

◯ガラスの立方体を3次元的に並べるプログラム

import bpy for i in range(0,5): for j in range(0,5): for k in range(0,5): #新規マテリアルをつくる material_glass = bpy.data.materials.new('Red') #ノードを使えるようにする material_glass.use_nodes = True bpy.ops.mesh.primitive_cube_add( size=0.8, #それぞれ縦、横、高さを決める location=(i, j, k), ) p_BSDF = material_glass.node_tree.nodes["Principled BSDF"] p_BSDF.inputs[0].default_value = (1, 0, 0, 1) p_BSDF.inputs[7].default_value = 0 p_BSDF.inputs[15].default_value = 1 bpy.context.object.data.materials.append(material_glass)

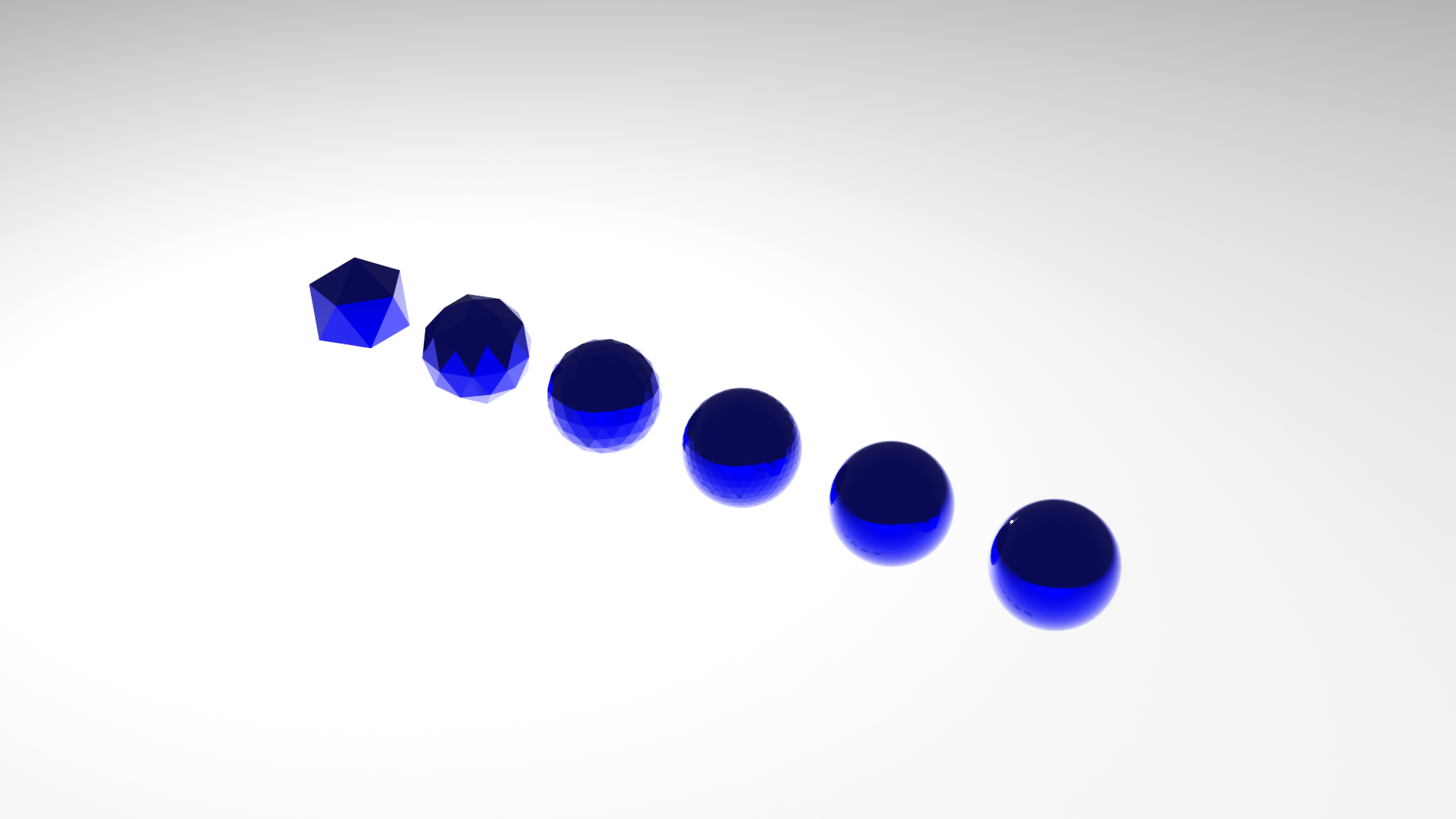

2.メタリックをつくってみよう!!

◯メタリックのico_spehreを並べるプログラム

import bpy #6回処理を繰り返す for i in range(0,6): #新規マテリアルをつくる material_glass = bpy.data.materials.new('Blue') #ノードを使えるようにする material_glass.use_nodes = True #ico_sphereを追加する関数 bpy.ops.mesh.primitive_ico_sphere_add( #どんどん滑らかにしていく subdivisions=i+1, location=(i, 0, 0), scale=(0.7, 0.7, 0.7) ) p_BSDF = material_glass.node_tree.nodes["Principled BSDF"] #0→BaseColor/4→Metallic(=金属)/7→roughness(=粗さ) p_BSDF.inputs[0].default_value = (0, 0, 1, 0.5) p_BSDF.inputs[4].default_value = 1 p_BSDF.inputs[7].default_value = 0 #オブジェクトにマテリアルの要素を追加する bpy.context.object.data.materials.append(material_glass)

◯少しずつ色を変えていくプログラム

処理を繰り返す度に変化するiを色に代入することで色を少しずつ変化させることができます。

import bpy import math import random for i in range(0,10): #0から1までのランダムな値を変数numに代入する num = random.random() material_glass = bpy.data.materials.new('Blue') material_glass.use_nodes = True bpy.ops.mesh.primitive_torus_add( #180(度)×0~1のランダムな値 rotation=(math.pi * num, math.pi * num, 0), major_segments=64, minor_segments=3, major_radius=10-i, minor_radius=0.1, ) p_BSDF = material_glass.node_tree.nodes["Principled BSDF"] p_BSDF.inputs[4].default_value = 1 p_BSDF.inputs[7].default_value = 0 p_BSDF.inputs[0].default_value = (0, 0, 1 - i/10, 1) bpy.context.object.data.materials.append(material_glass)

3.テキストを追加しよう!!

3-1.テキストの追加方法

◯シンプルなテキストの入力を行います。

import bpy #テキストを追加して編集モードで編集できるようにする bpy.ops.object.text_add(enter_editmode = True,location = (0,0,0)) #初期テキストを削除する bpy.ops.font.delete(type = 'PREVIOUS_WORD') #テキストを入力する bpy.ops.font.text_insert(text = 'Blender') #編集モードを終了する bpy.ops.object.editmode_toggle()

3-1.メタリックなテキストをつくる

◯テキストにメタリックのマテリアルを組み合わせます。

import bpy material_glass = bpy.data.materials.new('Blue') #ノードを使えるようにする material_glass.use_nodes = True #テキストを追加して編集モードで編集できるようにする bpy.ops.object.text_add(enter_editmode = True,location = (0,0,0)) #初期テキストを削除する bpy.ops.font.delete(type = 'PREVIOUS_WORD') #テキストを入力する bpy.ops.font.text_insert(text = 'Blender') #編集モードを終了する bpy.ops.object.editmode_toggle() #ノードをいじる p_BSDF = material_glass.node_tree.nodes["Principled BSDF"] p_BSDF.inputs[4].default_value = 1 p_BSDF.inputs[7].default_value = 0 p_BSDF.inputs[0].default_value = (0, 0, 1, 1) bpy.context.object.data.materials.append(material_glass)

4.英単語

英単語 訳 material 素材 default デフォルト/既定 value 値 append 加える object もの、物体 edit 編集 type 種類 delete 消去 toggle 切り替え operation(ops) 運用 add 追加 segment 区分、分割 insert 挿入する input 取得する、入手する previous 以前の、前の principled 原理、原則 subdivision 細分化

- 投稿日:2020-11-13T20:04:04+09:00

fastTextがさらにすごい!「Yahoo!ニュース」クラスタリング 〜教師なし学習編〜

前回はYahooニュースの記事データに対して、fastTextのtrain_supervisedメソッドを使って教師あり学習を行い、クラスタリングを行いました。

今回はfastTextのtrain_unsupervisedメソッドを使って教師なし学習を行い、前回の様に綺麗にクラスタリングできるか分析してみましょう。開発環境

- Docker

- JupyterLab

実装スタート

①ライブラリ読み込み

②utility.pyと言うファイルを作成して、今まで作成した関数を格納しています。そこから、今回必要な関数を読み込みます。

③YN関数を使ってYahooニュースの記事を取得します。約10で500記事ほど取得できます。この関数はこちらで紹介しています。# ① import pandas as pd, numpy as np from sklearn.model_selection import train_test_split import fasttext from sklearn import preprocessing from sklearn.decomposition import PCA import matplotlib.pyplot as plt import japanize_matplotlib import re# ② import utility as util wakati = util.wakati M2A = util.MecabMorphologicalAnalysis YN = util.YahooNews cos_sim = util.cos_sim# ③ df = YN(1000) # df = pd.read_csv('./YahooNews.csv') # すでにデータを取得済の場合は読み込んで分析スタート! df[====================] 502記事

title category text 0 パナ 22年に持ち株会社へ移行 経済 ブルームバーグ パナソニックは13日2022年4月から持ち株会社体制に移行すると発表した社名... 1 全国で1700人超感染 過去最多 国内 Nippon News NetworkNNN新型コロナウイルスの13日一日の新たな感染者はN... 2 眞子さまの結婚 両陛下も尊重 国内 宮内庁は13日秋篠宮ご夫妻の長女眞子さまと国際基督教大学ICU時代の同級生小室圭さん29と... 3 トランプ氏 子の助言分かれる 国際 CNN 米大統領選で敗北が確実となったトランプ大統領が次の一手の戦略を練るなか同氏の最も信頼... 4 国交相「GoTo延長したい」 国内 CopyrightC Japan News Network All rights reser... ... ... ... ... 497 バイデン氏 国民向けTV演説へ 国際 AFP時事米民主党の大統領候補ジョーバイデンJoe Biden氏が6日夜日本時間7日午前国民... 498 全米各地で衝突や暴動警戒 国際 All Nippon NewsNetworkANN アメリカでは大統領選挙の勝者が確定しない... 499 日中ビジネス往来 再開で合意 国内 日中両政府が新型コロナウイルス対策のため制限しているビジネス関係者らの往来を今月中旬にも再... 500 大統領選 ジョージア再集計へ 国際 AFP時事更新米大統領選で民主党のジョーバイデンJoe Biden氏が共和党のドナルドトラン... 501 IOCバッハ会長 15日に来日へ スポーツ 来夏に延期された東京五輪パラリンピックをめぐり国際オリンピック委員会IOCのトーマスバッハ... 502 rows × 3 columns

subwordについて

前回は触れなかったのですが、今回はfastTextの大きな特徴であるsubwordを考慮してみようと思います。

subwordとは単語をさらに細かな「部分語」に分割して単語の関連性を捉えようと言うものです。

例えば「Go」と「Going」の様な共通部分を持つ語句について、その関連性を学習できます。

subwordを適応すると精度が上がったので使用しようと思います。逆にカタカタ語に対しては弊害もある様です。

train_supervisedやtrain_unsupervisedの引数にmaxnとminnを渡すことで実装できます。

train_supervisedとtrain_unsupervisedでデフォルト値が異なります。詳しくはGitHubへ。教師あり学習(train_supervised)

まずは、比較のために前回の内容を一気に実行。

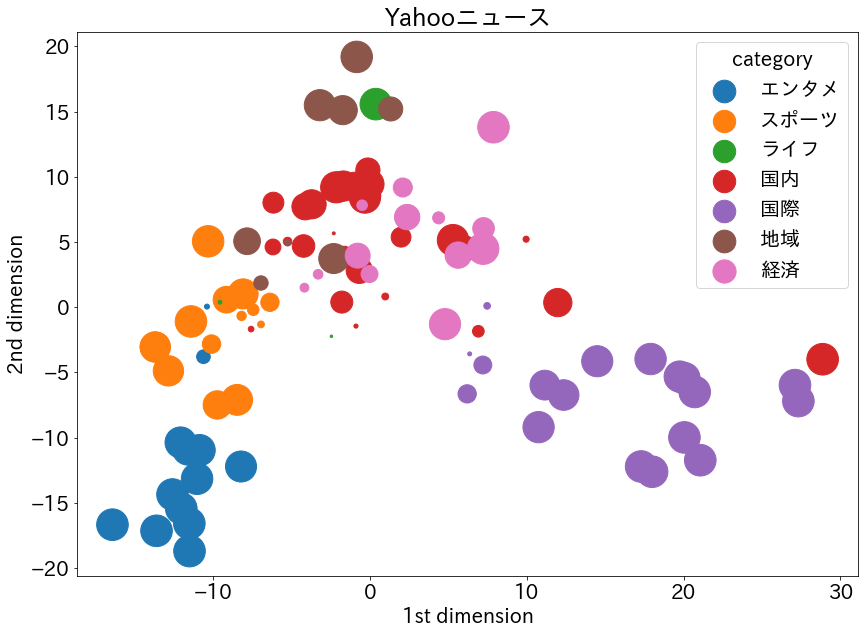

# カテゴリと本文をそれぞれリストに格納 cat_lst = ['__label__' + cat for cat in df.category] text_lst = [M2A(text, mecab=wakati) for text in df.text] # trainとvalidに分割 text_train, text_valid, cat_train, cat_valid = train_test_split( text_lst, cat_lst, test_size=0.2, random_state=0, stratify=cat_lst ) # trainファイルとvalidファイル作成 with open('./s_train', mode='w') as f: for i in range(len(text_train)): f.write(cat_train[i] + ' '+ text_train[i]) with open('./s_valid', mode='w') as f: for i in range(len(text_valid)): f.write(cat_valid[i] + ' ' + text_valid[i]) # モデルの学習 model = fasttext.train_supervised(input='./s_train', lr=0.5, epoch=500, minn=3, maxn=5, wordNgrams=3, loss='ova', dim=300, bucket=200000) # モデルの精度を確認 # print("TrainData:", model.test('./s_news_train')) print("ValidData:", model.test('./s_valid')) # validデータを使って2次元プロットの準備 with open("./s_valid") as f: l_strip = [s.strip() for s in f.readlines()] # strip()を利用することにより改行文字除去 labels = [] texts = [] sizes = [] for t in l_strip: labels.append(re.findall('__label__(.*?) ', t)[0]) texts.append(re.findall(' (.*)', t)[0]) sizes.append(model.predict(re.findall(' (.*)', t))[1][0][0]) # validの記事本文からベクトル生成 vectors = [] for t in texts: vectors.append(model.get_sentence_vector(t)) # numpyに変換 vectors = np.array(vectors) labels = np.array(labels) sizes = np.array(sizes) # 標準化 ss = preprocessing.StandardScaler() vectors_std = ss.fit_transform(vectors) # 次元削減 pca = PCA() pca.fit(vectors_std) feature = pca.transform(vectors_std) feature = feature[:, :2] # プロット x0, y0, z0 = feature[labels=='エンタメ', 0], feature[labels=='エンタメ', 1], sizes[labels=='エンタメ']*1000 x1, y1, z1 = feature[labels=='スポーツ', 0], feature[labels=='スポーツ', 1], sizes[labels=='スポーツ']*1000 x2, y2, z2 = feature[labels=='ライフ', 0], feature[labels=='ライフ', 1], sizes[labels=='ライフ']*1000 x3, y3, z3 = feature[labels=='国内', 0], feature[labels=='国内', 1], sizes[labels=='国内']*1000 x4, y4, z4 = feature[labels=='国際', 0], feature[labels=='国際', 1], sizes[labels=='国際']*1000 x5, y5, z5 = feature[labels=='地域', 0], feature[labels=='地域', 1], sizes[labels=='地域']*1000 x6, y6, z6 = feature[labels=='経済', 0], feature[labels=='経済', 1], sizes[labels=='経済']*1000 plt.figure(figsize=(14, 10)) plt.rcParams["font.size"]=20 plt.scatter(x0, y0, label="エンタメ", s=z0) plt.scatter(x1, y1, label="スポーツ", s=z1) plt.scatter(x2, y2, label="ライフ", s=z2) plt.scatter(x3, y3, label="国内", s=z3) plt.scatter(x4, y4, label="国際", s=z4) plt.scatter(x5, y5, label="地域", s=z5) plt.scatter(x6, y6, label="経済", s=z6) plt.title("Yahooニュース") plt.xlabel('1st dimension') plt.ylabel('2nd dimension') plt.legend(title="category") plt.show()ValidData: (101, 0.801980198019802, 0.801980198019802)教師なし学習(train_unsupervised)

データの準備

教師なし学習にはラベルが必要ないので、学習するためのデータは分かち書きしておくだけでOKです。

①カテゴリはcat_lstへ、文章はM2A関数で分かち書きしてtext_lstへそれぞれ格納します。

②trainデータとvalidデータに分割します。

③文章はファイルに保存しておきます。# ① cat_lst = [cat for cat in df.category] text_lst = [M2A(text, mecab=wakati) for text in df.text] # ② text_train, text_valid, cat_train, cat_valid = train_test_split( text_lst, cat_lst, test_size=0.2, random_state=0, stratify=cat_lst ) # ③ with open('./u_train', mode='w') as f: for i in range(len(text_train)): f.write(text_train[i]) with open('./u_valid', mode='w') as f: for i in range(len(text_valid)): f.write(text_valid[i])モデルの学習

教師なし学習は

train_unsupervisedを使用します。model = fasttext.train_unsupervised('./u_train', epoch=500, lr=0.01, minn=3, maxn=5, dim=300)trainデータ分析

文章ベクトルの類似度比較

学習済モデルを使用して、記事内容の類似度を算出しましょう。

①get_sentence_vectorメソッドを使用して学習済モデルから文章ベクトルを生成します。

②記事のカテゴリと本文を表示。

③上で読み込んだcos_sim関数を用いてコサイン類似度を算出。# ① vectors = [] for t in text_train: vectors.append(model.get_sentence_vector(t.strip())) # ② print("<{}>".format(cat_train[0])) print(text_train[0][:200], end="\n\n") print("<{}>".format(cat_train[1])) print(text_train[1][:200], end="\n\n") print("<{}>".format(cat_train[2])) print(text_train[2][:200], end="\n\n") # ③ print("<{}><{}>".format(cat_train[0], cat_train[1]), cos_sim(vectors[0], vectors[1])) print("<{}><{}>".format(cat_train[1], cat_train[2]), cos_sim(vectors[1], vectors[2])) print("<{}><{}>".format(cat_train[0], cat_train[2]), cos_sim(vectors[0], vectors[2]))<国内> 政府 の 新型コロナ ウイルス対策 分科会 の 尾身茂 会長 地域医療機能推進機構 理事長 は 9日 緊急 で 記者会見 を 開き 感染 が 全国的 に 見 て も 増加 し て いる の は 間違い ない 減少 要因 を 早急 に 強め なけれ ば いま は 徐々に だ が 急速 な 拡大 傾向 に 至る 可能性 が 高い と 訴え た そして 政府 へ の 緊急 提言 として 1 いま まで <国内> 昨年7月 の 参院選 を めぐり 公職選挙法違反 買収 の 罪 に 問わ れ た 参院 議員 河井案里 被告 47 の 被告人 質問 が 13日 午前 東京地裁 で 始まっ た 案 里 議員 は 地元 議員 ら に 現金 を 渡し た こと について 当選 祝い や 陣中 見舞い だっ た と 初公判 で 述べ た 主張 を 繰り返し 違法性 が ない と 訴え た スーツ姿 の 案 里 議員 は <国際> AFP 時事 更新 ドナルドトランプ Donald Trump 米大統領 は 9日 ツイッター Twitter へ の 投稿 で マークエスパー Mark Esper 国防長官 を 解任 し た こと を 明らか に し た 大統領選 で の 敗北 を 認め ない トランプ氏 へ の 対応 に 追わ れる 政権 に さらなる 揺さぶり が かけ られ た トランプ氏 は 投稿 で マークエスパー <国内><国内> 0.91201633 <国内><国際> 0.9294117 <国内><国際> 0.92017622次元プロット

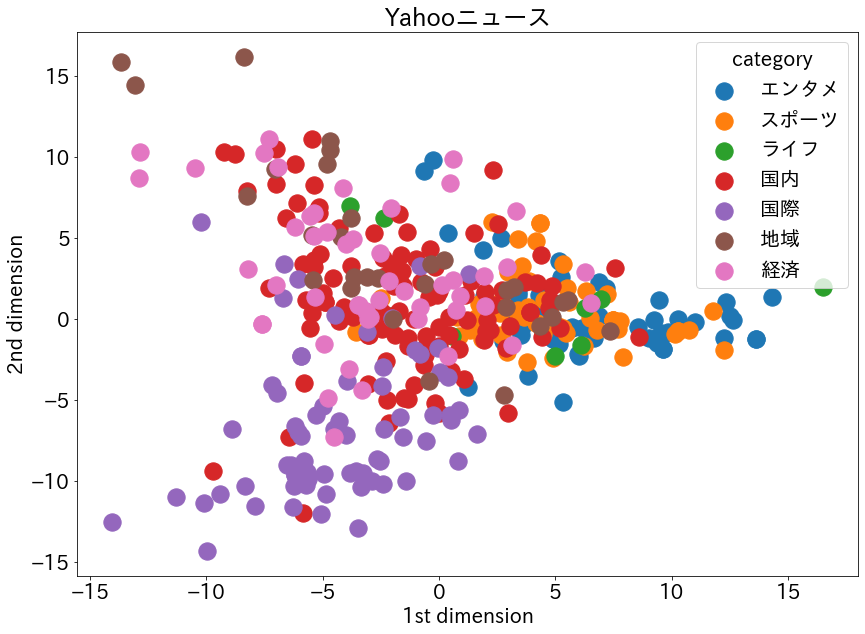

いよいよ2次元にプロットしてみましょう。

①ベクトルとラベルをそれぞれnumpy配列に変換

②ベクトルを標準化

③ベクトルをPCAを用いて次元削減

④matplotlibでプロット。train_supervisedと異なり、予測に対する確率を取得できないので、全てのプロットのサイズは同じ。# ① vectors = np.array(vectors) labels = np.array(cat_train) # ② ss = preprocessing.StandardScaler() vectors_std = ss.fit_transform(vectors) # ③ pca = PCA() pca.fit(vectors_std) feature = pca.transform(vectors_std) feature = feature[:, :2] # ④ x0, y0 = feature[labels=='エンタメ', 0], feature[labels=='エンタメ', 1] x1, y1 = feature[labels=='スポーツ', 0], feature[labels=='スポーツ', 1] x2, y2 = feature[labels=='ライフ', 0], feature[labels=='ライフ', 1] x3, y3 = feature[labels=='国内', 0], feature[labels=='国内', 1] x4, y4 = feature[labels=='国際', 0], feature[labels=='国際', 1] x5, y5 = feature[labels=='地域', 0], feature[labels=='地域', 1] x6, y6 = feature[labels=='経済', 0], feature[labels=='経済', 1] plt.figure(figsize=(14, 10)) plt.rcParams["font.size"]=20 plt.scatter(x0, y0, label="エンタメ", s=300) plt.scatter(x1, y1, label="スポーツ", s=300) plt.scatter(x2, y2, label="ライフ", s=300) plt.scatter(x3, y3, label="国内", s=300) plt.scatter(x4, y4, label="国際", s=300) plt.scatter(x5, y5, label="地域", s=300) plt.scatter(x6, y6, label="経済", s=300) plt.title("Yahooニュース") plt.xlabel('1st dimension') plt.ylabel('2nd dimension') plt.legend(title="category") plt.show()validデータ分析

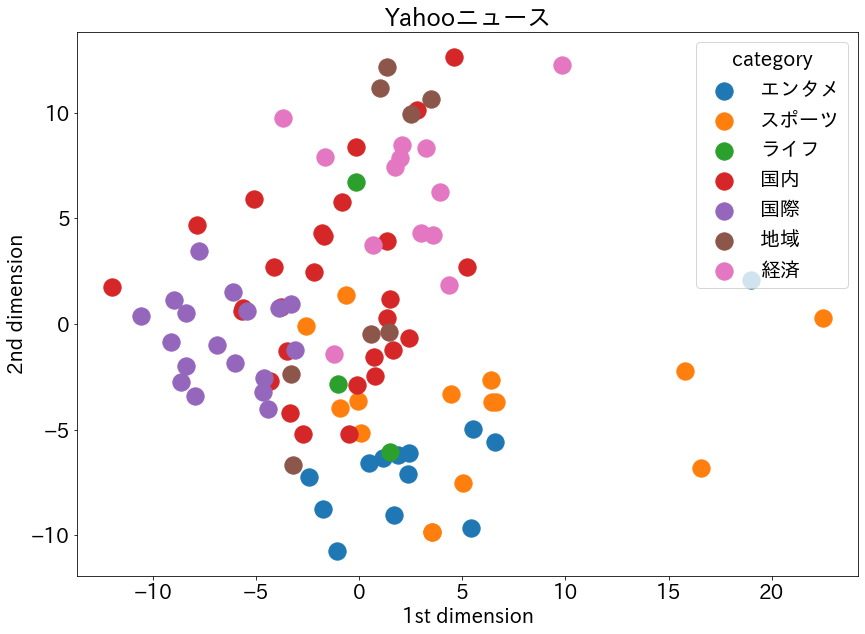

次に、validデータをクラスタリングしてみます。

内容はtrainデータ分析と同じですので解説を省略します。vectors = [] for t in text_valid: vectors.append(model.get_sentence_vector(t.strip())) print("<{}>".format(cat_valid[0])) print(text_valid[0][:200], end="\n\n") print("<{}>".format(cat_valid[1])) print(text_valid[1][:200], end="\n\n") print("<{}>".format(cat_valid[2])) print(text_valid[2][:200], end="\n\n") print("<{}><{}>".format(cat_valid[0], cat_valid[1]), cos_sim(vectors[0], vectors[1])) print("<{}><{}>".format(cat_valid[1], cat_valid[2]), cos_sim(vectors[1], vectors[2])) print("<{}><{}>".format(cat_valid[0], cat_valid[2]), cos_sim(vectors[0], vectors[2]))<経済> 近畿日本ツーリスト など を 傘下 に 持つ KNT ― CT ホールディングス HD は 11日 希望退職 など で グループ 従業員 約 7000人 の 3分の1 を 2025年 3月 まで に 削減 する と 発表 し た 個人旅行 を 扱う 全国 138 の 店舗 も 3分の2 を 22年 3月 まで に 閉鎖 する 新型コロナウイルス 感染拡大 に 伴う 旅行 需要 の 激減 で 業績 <地域> 北海道 の 新型コロナウイルス へ の 感染者 が 11月9日 過去最多 200人 を 超える 見通し と なっ た こと が わかり まし た 5日 連続 の 100人 超 が ついに 200人 台 へ の 到達 見込み と なり 感染拡大 が 止まり ませ ん 新た な クラスター が 確認 さ れ て いる と み られ ます 北海道 で は 5日 に 119人 の 感染者 が 確認 さ れ <経済> 日立製作所 は 9日 年末年始 の 休暇 の 分散 取得 など を 求める 政府 の 方針 を 受け 12月28日 来年 1月8日 まで を 対象 期間 と し 有休 取得 を 促す と 発表 し た 通常 は 12月30日 から 1月3日 まで グループ会社 の 社員 を 含む 約 15万人 が 対象 で 社内 の 年末年始 行事 や 不要不急 の 会議 の 開催 を 避け 休暇 を 取得 し <経済><地域> 0.9284181 <地域><経済> 0.90896636 <経済><経済> 0.9533808vectors = np.array(vectors) labels = np.array(cat_valid) ss = preprocessing.StandardScaler() vectors_std = ss.fit_transform(vectors) pca = PCA() pca.fit(vectors_std) feature = pca.transform(vectors_std) feature = feature[:, :2] x0, y0 = feature[labels=='エンタメ', 0], feature[labels=='エンタメ', 1] x1, y1 = feature[labels=='スポーツ', 0], feature[labels=='スポーツ', 1] x2, y2 = feature[labels=='ライフ', 0], feature[labels=='ライフ', 1] x3, y3 = feature[labels=='国内', 0], feature[labels=='国内', 1] x4, y4 = feature[labels=='国際', 0], feature[labels=='国際', 1] x5, y5 = feature[labels=='地域', 0], feature[labels=='地域', 1] x6, y6 = feature[labels=='経済', 0], feature[labels=='経済', 1] plt.figure(figsize=(14, 10)) plt.rcParams["font.size"]=20 plt.scatter(x0, y0, label="エンタメ", s=300) plt.scatter(x1, y1, label="スポーツ", s=300) plt.scatter(x2, y2, label="ライフ", s=300) plt.scatter(x3, y3, label="国内", s=300) plt.scatter(x4, y4, label="国際", s=300) plt.scatter(x5, y5, label="地域", s=300) plt.scatter(x6, y6, label="経済", s=300) plt.title("Yahooニュース") plt.xlabel('1st dimension') plt.ylabel('2nd dimension') plt.legend(title="category") plt.show()考察

教師あり学習

- subwordを採用したことで、前回記事の時よりさらに精度が向上しました。0.75→0.80

- 前回同様、1次元目では「エンタメ」と「スポーツ」は重なる部分が多いが、2次元目でしっかり分かれている。「エンタメ」と「スポーツ」が近い位置にあるのは納得。

- 「国際」と「国内」もしっかり分かれており、その間に「経済」がある。前回同様これも納得。

- 前回記事において「地域」ははっきりしていなかったが、今回は2次元方向に特徴が強く出ている。

- 全体として前回よりもはっきり分類された感じがします。

教師なし学習

trainデータ

- カテゴリごとに重なっている部分が多い。

- 「国際」と「国内」はしっかり分かれている。

- 「経済」は「国際」と「国内」の間にあると言うのがお決まりのパターンであったが、今回は広い範囲にプロットされてしまっている。

- 「エンタメ」と「スポーツ」はかなりの部分が重なっているが、一次元方向において「エンタメ」が若干右より、「スポーツ」が左に位置した。

- 「地域」は「国際」と重なる部分がほとんどなく、これは納得。「国内」、「経済」とかなりの部分が重なっている。

validデータ

- 重なっている部分が少なく、全体として綺麗に分類された。

- 中央に「国内」があり、左側に「国際」、中央上に「経済」と言う配置になった。今までとは随分違う。

- 今回も「スポーツ」と「エンタメ」はかなり近い位置にあるが、若干「スポーツ」が広い範囲に分布した。

- 「地域」は2つに分かれている。この傾向は、教師あり学習の方でも見て取れるため、何かの基準があるかもしれない。

今回は教師なし学習で分析を行いましたが、割と綺麗に分類が成功していて驚きました。

ラベルがないので、文章の中から「国際」っぽさや「スポーツ」っぽさを取得できていると言うことになります。実際にモデルがどの様な特徴を取得して、ベクトル作成に反映させているのか非常に気になります。

fastTextについてさらに深掘りしてみたくなりました!!!参考文献

Yahoo!ニュース

fastText

Facebookが公開したfastTextのインストールと使用方法について解説

fastTextのsubword(部分語)の弊害

fastText tutorial(Word representations)

GitHub (fastText/python)

fastTextがすごい!「Yahoo!ニュース」をクラスタリング

- 投稿日:2020-11-13T20:04:04+09:00

fastTextがかなりすごい!「Yahoo!ニュース」クラスタリング 〜教師なし学習編〜

前回はYahooニュースの記事データに対して、fastTextのtrain_supervisedメソッドを使って教師あり学習を行い、クラスタリングを行いました。

今回はfastTextのtrain_unsupervisedメソッドを使って教師なし学習を行い、前回の様に綺麗にクラスタリングできるか分析してみましょう。開発環境

- Docker

- JupyterLab

実装スタート

①ライブラリ読み込み

②utility.pyと言うファイルを作成して、今まで作成した関数を格納しています。そこから、今回必要な関数を読み込みます。

③YN関数を使ってYahooニュースの記事を取得します。約10で500記事ほど取得できます。この関数はこちらで紹介しています。# ① import pandas as pd, numpy as np from sklearn.model_selection import train_test_split import fasttext from sklearn import preprocessing from sklearn.decomposition import PCA import matplotlib.pyplot as plt import japanize_matplotlib import re# ② import utility as util wakati = util.wakati M2A = util.MecabMorphologicalAnalysis YN = util.YahooNews cos_sim = util.cos_sim# ③ df = YN(1000) # df = pd.read_csv('./YahooNews.csv') # すでにデータを取得済の場合は読み込んで分析スタート! df[====================] 502記事

title category text 0 パナ 22年に持ち株会社へ移行 経済 ブルームバーグ パナソニックは13日2022年4月から持ち株会社体制に移行すると発表した社名... 1 全国で1700人超感染 過去最多 国内 Nippon News NetworkNNN新型コロナウイルスの13日一日の新たな感染者はN... 2 眞子さまの結婚 両陛下も尊重 国内 宮内庁は13日秋篠宮ご夫妻の長女眞子さまと国際基督教大学ICU時代の同級生小室圭さん29と... 3 トランプ氏 子の助言分かれる 国際 CNN 米大統領選で敗北が確実となったトランプ大統領が次の一手の戦略を練るなか同氏の最も信頼... 4 国交相「GoTo延長したい」 国内 CopyrightC Japan News Network All rights reser... ... ... ... ... 497 バイデン氏 国民向けTV演説へ 国際 AFP時事米民主党の大統領候補ジョーバイデンJoe Biden氏が6日夜日本時間7日午前国民... 498 全米各地で衝突や暴動警戒 国際 All Nippon NewsNetworkANN アメリカでは大統領選挙の勝者が確定しない... 499 日中ビジネス往来 再開で合意 国内 日中両政府が新型コロナウイルス対策のため制限しているビジネス関係者らの往来を今月中旬にも再... 500 大統領選 ジョージア再集計へ 国際 AFP時事更新米大統領選で民主党のジョーバイデンJoe Biden氏が共和党のドナルドトラン... 501 IOCバッハ会長 15日に来日へ スポーツ 来夏に延期された東京五輪パラリンピックをめぐり国際オリンピック委員会IOCのトーマスバッハ... 502 rows × 3 columns

subwordについて

前回は触れなかったのですが、今回はfastTextの大きな特徴であるsubwordを考慮してみようと思います。

subwordとは単語をさらに細かな「部分語」に分割して単語の関連性を捉えようと言うものです。

例えば「Go」と「Going」の様な共通部分を持つ語句について、その関連性を学習できます。

subwordを適応すると精度が上がったので使用しようと思います。逆にカタカタ語に対しては弊害もある様です。

train_supervisedやtrain_unsupervisedの引数にmaxnとminnを渡すことで実装できます。

train_supervisedとtrain_unsupervisedでデフォルト値が異なります。詳しくはGitHubへ。教師あり学習(train_supervised)

まずは、比較のために前回の内容を一気に実行。

# カテゴリと本文をそれぞれリストに格納 cat_lst = ['__label__' + cat for cat in df.category] text_lst = [M2A(text, mecab=wakati) for text in df.text] # trainとvalidに分割 text_train, text_valid, cat_train, cat_valid = train_test_split( text_lst, cat_lst, test_size=0.2, random_state=0, stratify=cat_lst ) # trainファイルとvalidファイル作成 with open('./s_train', mode='w') as f: for i in range(len(text_train)): f.write(cat_train[i] + ' '+ text_train[i]) with open('./s_valid', mode='w') as f: for i in range(len(text_valid)): f.write(cat_valid[i] + ' ' + text_valid[i]) # モデルの学習 model = fasttext.train_supervised(input='./s_train', lr=0.5, epoch=500, minn=3, maxn=5, wordNgrams=3, loss='ova', dim=300, bucket=200000) # モデルの精度を確認 # print("TrainData:", model.test('./s_news_train')) print("ValidData:", model.test('./s_valid')) # validデータを使って2次元プロットの準備 with open("./s_valid") as f: l_strip = [s.strip() for s in f.readlines()] # strip()を利用することにより改行文字除去 labels = [] texts = [] sizes = [] for t in l_strip: labels.append(re.findall('__label__(.*?) ', t)[0]) texts.append(re.findall(' (.*)', t)[0]) sizes.append(model.predict(re.findall(' (.*)', t))[1][0][0]) # validの記事本文からベクトル生成 vectors = [] for t in texts: vectors.append(model.get_sentence_vector(t)) # numpyに変換 vectors = np.array(vectors) labels = np.array(labels) sizes = np.array(sizes) # 標準化 ss = preprocessing.StandardScaler() vectors_std = ss.fit_transform(vectors) # 次元削減 pca = PCA() pca.fit(vectors_std) feature = pca.transform(vectors_std) feature = feature[:, :2] # プロット x0, y0, z0 = feature[labels=='エンタメ', 0], feature[labels=='エンタメ', 1], sizes[labels=='エンタメ']*1000 x1, y1, z1 = feature[labels=='スポーツ', 0], feature[labels=='スポーツ', 1], sizes[labels=='スポーツ']*1000 x2, y2, z2 = feature[labels=='ライフ', 0], feature[labels=='ライフ', 1], sizes[labels=='ライフ']*1000 x3, y3, z3 = feature[labels=='国内', 0], feature[labels=='国内', 1], sizes[labels=='国内']*1000 x4, y4, z4 = feature[labels=='国際', 0], feature[labels=='国際', 1], sizes[labels=='国際']*1000 x5, y5, z5 = feature[labels=='地域', 0], feature[labels=='地域', 1], sizes[labels=='地域']*1000 x6, y6, z6 = feature[labels=='経済', 0], feature[labels=='経済', 1], sizes[labels=='経済']*1000 plt.figure(figsize=(14, 10)) plt.rcParams["font.size"]=20 plt.scatter(x0, y0, label="エンタメ", s=z0) plt.scatter(x1, y1, label="スポーツ", s=z1) plt.scatter(x2, y2, label="ライフ", s=z2) plt.scatter(x3, y3, label="国内", s=z3) plt.scatter(x4, y4, label="国際", s=z4) plt.scatter(x5, y5, label="地域", s=z5) plt.scatter(x6, y6, label="経済", s=z6) plt.title("Yahooニュース") plt.xlabel('1st dimension') plt.ylabel('2nd dimension') plt.legend(title="category") plt.show()ValidData: (101, 0.801980198019802, 0.801980198019802)教師なし学習(train_unsupervised)

データの準備

教師なし学習にはラベルが必要ないので、学習するためのデータは分かち書きしておくだけでOKです。

①カテゴリはcat_lstへ、文章はM2A関数で分かち書きしてtext_lstへそれぞれ格納します。

②trainデータとvalidデータに分割します。

③文章はファイルに保存しておきます。# ① cat_lst = [cat for cat in df.category] text_lst = [M2A(text, mecab=wakati) for text in df.text] # ② text_train, text_valid, cat_train, cat_valid = train_test_split( text_lst, cat_lst, test_size=0.2, random_state=0, stratify=cat_lst ) # ③ with open('./u_train', mode='w') as f: for i in range(len(text_train)): f.write(text_train[i]) with open('./u_valid', mode='w') as f: for i in range(len(text_valid)): f.write(text_valid[i])モデルの学習

教師なし学習は

train_unsupervisedを使用します。model = fasttext.train_unsupervised('./u_train', epoch=500, lr=0.01, minn=3, maxn=5, dim=300)trainデータ分析

文章ベクトルの類似度比較

学習済モデルを使用して、記事内容の類似度を算出しましょう。

①get_sentence_vectorメソッドを使用して学習済モデルから文章ベクトルを生成します。

②記事のカテゴリと本文を表示。

③上で読み込んだcos_sim関数を用いてコサイン類似度を算出。# ① vectors = [] for t in text_train: vectors.append(model.get_sentence_vector(t.strip())) # ② print("<{}>".format(cat_train[0])) print(text_train[0][:200], end="\n\n") print("<{}>".format(cat_train[1])) print(text_train[1][:200], end="\n\n") print("<{}>".format(cat_train[2])) print(text_train[2][:200], end="\n\n") # ③ print("<{}><{}>".format(cat_train[0], cat_train[1]), cos_sim(vectors[0], vectors[1])) print("<{}><{}>".format(cat_train[1], cat_train[2]), cos_sim(vectors[1], vectors[2])) print("<{}><{}>".format(cat_train[0], cat_train[2]), cos_sim(vectors[0], vectors[2]))<国内> 政府 の 新型コロナ ウイルス対策 分科会 の 尾身茂 会長 地域医療機能推進機構 理事長 は 9日 緊急 で 記者会見 を 開き 感染 が 全国的 に 見 て も 増加 し て いる の は 間違い ない 減少 要因 を 早急 に 強め なけれ ば いま は 徐々に だ が 急速 な 拡大 傾向 に 至る 可能性 が 高い と 訴え た そして 政府 へ の 緊急 提言 として 1 いま まで <国内> 昨年7月 の 参院選 を めぐり 公職選挙法違反 買収 の 罪 に 問わ れ た 参院 議員 河井案里 被告 47 の 被告人 質問 が 13日 午前 東京地裁 で 始まっ た 案 里 議員 は 地元 議員 ら に 現金 を 渡し た こと について 当選 祝い や 陣中 見舞い だっ た と 初公判 で 述べ た 主張 を 繰り返し 違法性 が ない と 訴え た スーツ姿 の 案 里 議員 は <国際> AFP 時事 更新 ドナルドトランプ Donald Trump 米大統領 は 9日 ツイッター Twitter へ の 投稿 で マークエスパー Mark Esper 国防長官 を 解任 し た こと を 明らか に し た 大統領選 で の 敗北 を 認め ない トランプ氏 へ の 対応 に 追わ れる 政権 に さらなる 揺さぶり が かけ られ た トランプ氏 は 投稿 で マークエスパー <国内><国内> 0.91201633 <国内><国際> 0.9294117 <国内><国際> 0.92017622次元プロット

いよいよ2次元にプロットしてみましょう。

①ベクトルとラベルをそれぞれnumpy配列に変換

②ベクトルを標準化

③ベクトルをPCAを用いて次元削減

④matplotlibでプロット。train_supervisedと異なり、予測に対する確率を取得できないので、全てのプロットのサイズは同じ。# ① vectors = np.array(vectors) labels = np.array(cat_train) # ② ss = preprocessing.StandardScaler() vectors_std = ss.fit_transform(vectors) # ③ pca = PCA() pca.fit(vectors_std) feature = pca.transform(vectors_std) feature = feature[:, :2] # ④ x0, y0 = feature[labels=='エンタメ', 0], feature[labels=='エンタメ', 1] x1, y1 = feature[labels=='スポーツ', 0], feature[labels=='スポーツ', 1] x2, y2 = feature[labels=='ライフ', 0], feature[labels=='ライフ', 1] x3, y3 = feature[labels=='国内', 0], feature[labels=='国内', 1] x4, y4 = feature[labels=='国際', 0], feature[labels=='国際', 1] x5, y5 = feature[labels=='地域', 0], feature[labels=='地域', 1] x6, y6 = feature[labels=='経済', 0], feature[labels=='経済', 1] plt.figure(figsize=(14, 10)) plt.rcParams["font.size"]=20 plt.scatter(x0, y0, label="エンタメ", s=300) plt.scatter(x1, y1, label="スポーツ", s=300) plt.scatter(x2, y2, label="ライフ", s=300) plt.scatter(x3, y3, label="国内", s=300) plt.scatter(x4, y4, label="国際", s=300) plt.scatter(x5, y5, label="地域", s=300) plt.scatter(x6, y6, label="経済", s=300) plt.title("Yahooニュース") plt.xlabel('1st dimension') plt.ylabel('2nd dimension') plt.legend(title="category") plt.show()validデータ分析

次に、validデータをクラスタリングしてみます。

内容はtrainデータ分析と同じですので解説を省略します。vectors = [] for t in text_valid: vectors.append(model.get_sentence_vector(t.strip())) print("<{}>".format(cat_valid[0])) print(text_valid[0][:200], end="\n\n") print("<{}>".format(cat_valid[1])) print(text_valid[1][:200], end="\n\n") print("<{}>".format(cat_valid[2])) print(text_valid[2][:200], end="\n\n") print("<{}><{}>".format(cat_valid[0], cat_valid[1]), cos_sim(vectors[0], vectors[1])) print("<{}><{}>".format(cat_valid[1], cat_valid[2]), cos_sim(vectors[1], vectors[2])) print("<{}><{}>".format(cat_valid[0], cat_valid[2]), cos_sim(vectors[0], vectors[2]))<経済> 近畿日本ツーリスト など を 傘下 に 持つ KNT ― CT ホールディングス HD は 11日 希望退職 など で グループ 従業員 約 7000人 の 3分の1 を 2025年 3月 まで に 削減 する と 発表 し た 個人旅行 を 扱う 全国 138 の 店舗 も 3分の2 を 22年 3月 まで に 閉鎖 する 新型コロナウイルス 感染拡大 に 伴う 旅行 需要 の 激減 で 業績 <地域> 北海道 の 新型コロナウイルス へ の 感染者 が 11月9日 過去最多 200人 を 超える 見通し と なっ た こと が わかり まし た 5日 連続 の 100人 超 が ついに 200人 台 へ の 到達 見込み と なり 感染拡大 が 止まり ませ ん 新た な クラスター が 確認 さ れ て いる と み られ ます 北海道 で は 5日 に 119人 の 感染者 が 確認 さ れ <経済> 日立製作所 は 9日 年末年始 の 休暇 の 分散 取得 など を 求める 政府 の 方針 を 受け 12月28日 来年 1月8日 まで を 対象 期間 と し 有休 取得 を 促す と 発表 し た 通常 は 12月30日 から 1月3日 まで グループ会社 の 社員 を 含む 約 15万人 が 対象 で 社内 の 年末年始 行事 や 不要不急 の 会議 の 開催 を 避け 休暇 を 取得 し <経済><地域> 0.9284181 <地域><経済> 0.90896636 <経済><経済> 0.9533808vectors = np.array(vectors) labels = np.array(cat_valid) ss = preprocessing.StandardScaler() vectors_std = ss.fit_transform(vectors) pca = PCA() pca.fit(vectors_std) feature = pca.transform(vectors_std) feature = feature[:, :2] x0, y0 = feature[labels=='エンタメ', 0], feature[labels=='エンタメ', 1] x1, y1 = feature[labels=='スポーツ', 0], feature[labels=='スポーツ', 1] x2, y2 = feature[labels=='ライフ', 0], feature[labels=='ライフ', 1] x3, y3 = feature[labels=='国内', 0], feature[labels=='国内', 1] x4, y4 = feature[labels=='国際', 0], feature[labels=='国際', 1] x5, y5 = feature[labels=='地域', 0], feature[labels=='地域', 1] x6, y6 = feature[labels=='経済', 0], feature[labels=='経済', 1] plt.figure(figsize=(14, 10)) plt.rcParams["font.size"]=20 plt.scatter(x0, y0, label="エンタメ", s=300) plt.scatter(x1, y1, label="スポーツ", s=300) plt.scatter(x2, y2, label="ライフ", s=300) plt.scatter(x3, y3, label="国内", s=300) plt.scatter(x4, y4, label="国際", s=300) plt.scatter(x5, y5, label="地域", s=300) plt.scatter(x6, y6, label="経済", s=300) plt.title("Yahooニュース") plt.xlabel('1st dimension') plt.ylabel('2nd dimension') plt.legend(title="category") plt.show()考察

教師あり学習

- subwordを採用したことで、前回記事の時よりさらに精度が向上しました。0.75→0.80

- 前回同様、1次元目では「エンタメ」と「スポーツ」は重なる部分が多いが、2次元目でしっかり分かれている。「エンタメ」と「スポーツ」が近い位置にあるのは納得。

- 「国際」と「国内」もしっかり分かれており、その間に「経済」がある。前回同様これも納得。

- 前回記事において「地域」ははっきりしていなかったが、今回は2次元方向に特徴が強く出ている。

- 全体として前回よりもはっきり分類された感じがします。

教師なし学習

trainデータ

- カテゴリごとに重なっている部分が多い。

- 「国際」と「国内」はしっかり分かれている。

- 「経済」は「国際」と「国内」の間にあると言うのがお決まりのパターンであったが、今回は広い範囲にプロットされてしまっている。

- 「エンタメ」と「スポーツ」はかなりの部分が重なっているが、一次元方向において「エンタメ」が若干右より、「スポーツ」が左に位置した。

- 「地域」は「国際」と重なる部分がほとんどなく、これは納得。「国内」、「経済」とかなりの部分が重なっている。

validデータ

- 重なっている部分が少なく、全体として綺麗に分類された。

- 中央に「国内」があり、左側に「国際」、中央上に「経済」と言う配置になった。今までとは随分違う。

- 今回も「スポーツ」と「エンタメ」はかなり近い位置にあるが、若干「スポーツ」が広い範囲に分布した。

- 「地域」は2つに分かれている。この傾向は、教師あり学習の方でも見て取れるため、何かの基準があるかもしれない。

今回は教師なし学習で分析を行いましたが、割と綺麗に分類が成功していて驚きました。

ラベルがないので、文章の中から「国際」っぽさや「スポーツ」っぽさを取得できていると言うことになります。実際にモデルがどの様な特徴を取得して、ベクトル作成に反映させているのか非常に気になります。

fastTextについてさらに深掘りしてみたくなりました!!!参考文献

Yahoo!ニュース

fastText

Facebookが公開したfastTextのインストールと使用方法について解説

fastTextのsubword(部分語)の弊害

fastText tutorial(Word representations)

GitHub (fastText/python)

fastTextがすごい!「Yahoo!ニュース」をクラスタリング

- 投稿日:2020-11-13T19:53:58+09:00

C#でjsonを読み込み辞書型に変換(強引)

お久しぶりです。

Qiitaの皆さん、お久しぶりです。

前回からかなり時間がアイてしまいましたが、あれから念願の新しいパソコンを購入しました。

そしてPythonにも飽きてきたので、C#に手を出してみることにしました。ふと思ったjsonの読み込みについて

私は以前、Pythonでjsonを使用して設定ファイルやデータをイチイチに定義しなければならないものをjsonに格納して便利に使っていたので、ぜひC#でも使いたいと思い模索しました。

薄々気づいてはいましたが、Pythonはなんて素晴らしいライブラリを取り揃えているのかと思い知らされることになりました。json読み込みのコード

hoge.json{ "hoge": "hoge1", "hogehoge": "hoge2", "hogehogehoge": "hoge3" }Pythonでのjsonの読み込みはjsonライブラリを使用しますが

import json def load_json(filename): with open(filename) as files: load = json.load(files) return loadこのように関数を一つ定義してしまえば、辞書型で帰ってくるので

result = load_json("hoge.json") hoge1 = result["hoge"] hoge2 = result["hogehoge"] hoge3 = result["hogehogehoge"] print(hoge1) print(hoge2) print(hoge3) print(type(hoge1)) print(type(hoge2)) print(type(hoge3))hoge1 hoge2 hoge3 <class 'str'> <class 'str'> <class 'str'>こうすると簡単にstrやintで帰ってきますので、あとは煮るなり焼くなりすれば簡単に使うことができますが

(ガバコードデゴメンネ)C#の場合

using System; using System.IO; using System.Text; using System.Text.Json; namespace ConsoleApp2 { class Program { public static string ReadAllLine(string filePath, string encodingName) { StreamReader sr = new StreamReader(filePath, Encoding.GetEncoding(encodingName)); string allLine = sr.ReadToEnd(); sr.Close(); return allLine; } class hogejson { public string hoge { get; set; } public string hogehoge { get; set; } public string hogehogehoge { get; set; } } static void Main(string[] args) { string readjson = ReadAllLine("hoge.json", "utf-8"); hogejson jsonData = JsonSerializer.Deserialize<hogejson>(readjson); string hoge = jsonData.hoge; string hogehoge = jsonData.hogehoge; string hogehogehoge = jsonData.hogehogehoge; Console.WriteLine(hoge); Console.WriteLine(hogehoge); Console.WriteLine(hogehogehoge); Console.WriteLine(hoge.GetType()); Console.WriteLine(hogehoge.GetType()); Console.WriteLine(hogehogehoge.GetType()); } } }hoge1 hoge2 hoge3 System.String System.String System.Stringこんな感じで記載しないとうまく読み込まないのですが、一番個人的に面倒なのが

「jsonのクラスを作らないといけない」

のと

「メソッド(Pythonでいう関数(若干違うけど))作った時わかりにくい!

ことが引っかかりました。なぜこんなことになってしまったのか

Pythonは先程の関数で帰ってくる返り値は辞書型に対してC#は特定の返り値を指定しなければなりません。

このため、Pythonでは辞書型で帰ってくるのでhoge = result["hoge"]とresultに指定定するだけでkeyである「hoge」のvalue「hoge1」を取り出すことができますが

対してC#は、例えば「hoge.json」のkeyである「hoge」のvalueが「hoge1」であったとき、クラス「hogejson」のhogeにstring型(str)でセットされます。

逆にこれをint型や別の型でセットしようとしてもできません。なぜなら、クラスhogeの返り値はstringと決めているからです。

そのためPythonでよくお世話になった辞書型に返り値には指定されていないため、仮に返り値を"勝手"に辞書型に指定しても他の「hogehoge」や「hogehogehoge」のkeyはおろかvalueの情報すらありません(自己解釈)ほんじゃあ辞書型に返ってくるように作ろう!笑

探してみたところ、C#には「Dictionaryクラス」というものが存在するようで、それでPythonの辞書型と同じように使えるみたいです。

なら話は早いです、hoge.jsonのkeyとvalueを辞書型に詰め込めるよう試行錯誤を繰り返してできたのがこちらです。

using System; using System.Collections.Generic; using System.IO; using System.Text; using System.Text.Json; namespace ConsoleApp2 { class library { // ファイル読み込み public string ReadAllLine(string filePath, string encodingName) { StreamReader sr = new StreamReader(filePath, Encoding.GetEncoding(encodingName)); string allLine = sr.ReadToEnd(); sr.Close(); return allLine; } // List型をDictionary型に強引に変換する public static Dictionary<string, string> ListInDictionary(string[] left, string[] right) { // 一致したとき if (left.Length == right.Length) { var result = new Dictionary<string, string>(); // leftのListの数の分だけforを回す for (int i = 0; i < left.Length; i++) { // resultに辞書を追加 result.Add(left[i], right[i]); } return result; } // 不一致のとき else { return null; } } class hogejson { public string hoge { get; set; } public string hogehoge { get; set; } public string hogehogehoge { get; set; } } //hoge.jsonを読み込むためのメソッド public Dictionary<string, string> GetHogejson(string filename) { try { string jsonfile = ReadAllLine(filename, "utf-8"); hogejson jsonData = JsonSerializer.Deserialize<hogejson>(jsonfile); string[] json_key = { "hoge", "hogehoge", "hogehogehoge" }; string[] json_value = { jsonData.hoge, jsonData.hogehoge, jsonData.hogehogehoge }; var result = ListInDictionary(json_key, json_value); return result; } // jsonが読み込めない時 catch (JsonException) { return null; } } } class Program { static void Main(string[] args) { library Library = new library(); Dictionary<string, string> gethogejson = Library.GetHogejson("hoge.json"); string hoge, hogehoge, hogehogehoge; hoge = gethogejson["hoge"]; hogehoge = gethogejson["hogehoge"]; hogehogehoge = gethogejson["hogehogehoge"]; Console.WriteLine(hoge); Console.WriteLine(hogehoge); Console.WriteLine(hogehogehoge); Console.WriteLine(hoge.GetType()); Console.WriteLine(hogehoge.GetType()); Console.WriteLine(hogehogehoge.GetType()); } } }...自分でも感じた、強引すぎると...

問題点

- valueがint型だろうとなんだろうとstring型にしてresult(辞書型)に格納する。

- 結局jsonデータのクラスを指定しなければならないので、根本的な解決には至っていない。

- とりあえず思いついた発想と知恵で強引に作ったので、見られたら怒られるくらいのガバコード

個人的にはPythonのように使えるのが一番ありがたいですが、あまりに強引すぎて怒られるような気がします。

ちなみに結果は

hoge1 hoge2 hoge3 System.String System.String System.Stringこんなふうに表示されます。

最後に

この方法よりこっちのほうが使いやすいよ!

ガバすぎだろもっとこうするべきだ等あれば、ご遠慮無くぜひコメントまで!

結構真剣に困っていたので、また時間があれば改良してみます。久々に書ききりました。

おやすみなさい。引用元

https://usefuledge.com/csharp-json.html

https://json2csharp.com/ (先程のjsonデータクラスをjsonデータをもとに作ってくれるサイト、めっちゃ便利)

Thank you!!!!!

- 投稿日:2020-11-13T19:53:58+09:00

C#でjsonを読み込み・そして辞書型に変換(強引)

お久しぶりです。

Qiitaの皆さん、お久しぶりです。

前回からかなり時間が空きすぎましたが、あれから念願の新しいパソコンを購入しました。

そしてPythonにも飽きてきたので、C#に手を出してみることにしました。理解するメモとして書き残しておきます。

ガバな点はご容赦ください。ふと思ったjsonの読み込みについて

私は以前、Pythonでjsonを使用して設定ファイルやデータをイチイチに定義しなければならないものをjsonに格納して便利に使っていたので、ぜひC#でも使いたいと思い模索しました。

薄々気づいてはいましたが、Pythonはなんて素晴らしいライブラリを取り揃えているのかと思い知らされることになりました。json読み込みのコード

hoge.json{ "hoge": "hoge1", "hogehoge": "hoge2", "hogehogehoge": "hoge3" }Pythonでのjsonの読み込みはjsonライブラリを使用しますが

import json def load_json(filename): with open(filename) as files: load = json.load(files) return loadこのように関数を一つ定義してしまえば、辞書型で帰ってくるので

result = load_json("hoge.json") hoge1 = result["hoge"] hoge2 = result["hogehoge"] hoge3 = result["hogehogehoge"] print(hoge1) print(hoge2) print(hoge3) print(type(hoge1)) print(type(hoge2)) print(type(hoge3))hoge1 hoge2 hoge3 <class 'str'> <class 'str'> <class 'str'>こうすると簡単にstrやintで帰ってきますので、あとは煮るなり焼くなりすれば簡単に使うことができますが

(ガバコードデゴメンネ)C#の場合

using System; using System.IO; using System.Text; using System.Text.Json; namespace ConsoleApp2 { class Program { public static string ReadAllLine(string filePath, string encodingName) { StreamReader sr = new StreamReader(filePath, Encoding.GetEncoding(encodingName)); string allLine = sr.ReadToEnd(); sr.Close(); return allLine; } class hogejson { public string hoge { get; set; } public string hogehoge { get; set; } public string hogehogehoge { get; set; } } static void Main(string[] args) { string readjson = ReadAllLine("hoge.json", "utf-8"); hogejson jsonData = JsonSerializer.Deserialize<hogejson>(readjson); string hoge = jsonData.hoge; string hogehoge = jsonData.hogehoge; string hogehogehoge = jsonData.hogehogehoge; Console.WriteLine(hoge); Console.WriteLine(hogehoge); Console.WriteLine(hogehogehoge); Console.WriteLine(hoge.GetType()); Console.WriteLine(hogehoge.GetType()); Console.WriteLine(hogehogehoge.GetType()); } } }hoge1 hoge2 hoge3 System.String System.String System.Stringこんな感じで記載しないとうまく読み込まないのですが、一番個人的に面倒なのが

「jsonのクラスを作らないといけない」

のと

「メソッド(Pythonでいう関数(若干違うけど))作った時わかりにくい!

ことが引っかかりました。なぜこんなことになってしまったのか

Pythonは先程の関数で帰ってくる返り値は辞書型に対してC#は特定の返り値を指定しなければなりません。

このため、Pythonでは辞書型で帰ってくるのでhoge = result["hoge"]とresultに指定定するだけでkeyである「hoge」のvalue「hoge1」を取り出すことができますが

対してC#は、例えば「hoge.json」のkeyである「hoge」のvalueが「hoge1」であったとき、クラス「hogejson」のhogeにstring型(str)でセットされます。

逆にこれをint型や別の型でセットしようとしてもできません。なぜなら、クラスhogeの返り値はstringと決めているからです。

そのためPythonでよくお世話になった辞書型に返り値には指定されていないため、仮に返り値を"勝手"に辞書型に指定しても他の「hogehoge」や「hogehogehoge」のkeyはおろかvalueの情報すらありません(自己解釈)ほんじゃあ辞書型に返ってくるように作ろう!笑

探してみたところ、C#には「Dictionaryクラス」というものが存在するようで、それでPythonの辞書型と同じように使えるみたいです。

なら話は早いです、hoge.jsonのkeyとvalueを辞書型に詰め込めるよう試行錯誤を繰り返してできたのがこちらです。

using System; using System.Collections.Generic; using System.IO; using System.Text; using System.Text.Json; namespace ConsoleApp2 { class library { // ファイル読み込み public string ReadAllLine(string filePath, string encodingName) { StreamReader sr = new StreamReader(filePath, Encoding.GetEncoding(encodingName)); string allLine = sr.ReadToEnd(); sr.Close(); return allLine; } // List型をDictionary型に強引に変換する public static Dictionary<string, string> ListInDictionary(string[] left, string[] right) { // 一致したとき if (left.Length == right.Length) { var result = new Dictionary<string, string>(); // leftのListの数の分だけforを回す for (int i = 0; i < left.Length; i++) { // resultに辞書を追加 result.Add(left[i], right[i]); } return result; } // 不一致のとき else { return null; } } class hogejson { public string hoge { get; set; } public string hogehoge { get; set; } public string hogehogehoge { get; set; } } //hoge.jsonを読み込むためのメソッド public Dictionary<string, string> GetHogejson(string filename) { try { string jsonfile = ReadAllLine(filename, "utf-8"); hogejson jsonData = JsonSerializer.Deserialize<hogejson>(jsonfile); string[] json_key = { "hoge", "hogehoge", "hogehogehoge" }; string[] json_value = { jsonData.hoge, jsonData.hogehoge, jsonData.hogehogehoge }; var result = ListInDictionary(json_key, json_value); return result; } // jsonが読み込めない時 catch (JsonException) { return null; } } } class Program { static void Main(string[] args) { library Library = new library(); Dictionary<string, string> gethogejson = Library.GetHogejson("hoge.json"); string hoge, hogehoge, hogehogehoge; hoge = gethogejson["hoge"]; hogehoge = gethogejson["hogehoge"]; hogehogehoge = gethogejson["hogehogehoge"]; Console.WriteLine(hoge); Console.WriteLine(hogehoge); Console.WriteLine(hogehogehoge); Console.WriteLine(hoge.GetType()); Console.WriteLine(hogehoge.GetType()); Console.WriteLine(hogehogehoge.GetType()); } } }...自分でも感じた、強引すぎると...

問題点

- valueがint型だろうとなんだろうとstring型にしてresult(辞書型)に格納する。

- 結局jsonデータのクラスを指定しなければならないので、根本的な解決には至っていない。

- とりあえず思いついた発想と知恵で強引に作ったので、見られたら怒られるくらいのガバコード

個人的にはPythonのように使えるのが一番ありがたいですが、あまりに強引すぎて怒られるような気がします。

ちなみに結果は

hoge1 hoge2 hoge3 System.String System.String System.Stringこんなふうに表示されます。

最後に

この方法より「こうしたほうがいいよ~・

ガバすぎこれを使え」等あれば、ご遠慮無くぜひコメントまで!

結構真剣に困っていたので、また時間があれば改良してみます。追記

これなんなんですかね?よく出てきて動かなくなります。

こうなるともう保存して起動し直すしかないのでめっちゃ不便です。久々に書き切りました。

おやすみなさい。引用元

https://usefuledge.com/csharp-json.html

https://json2csharp.com/ (先程のjsonデータクラスをjsonデータをもとに作ってくれるサイト、めっちゃ便利)

Thank you!!!!!

- 投稿日:2020-11-13T19:50:09+09:00

4年間ほどデータエンジニアをしてみたので所感や知見を雑多に書き出してみる

4年ほどデータエンジニアをしてみて、いろいろ振り返りつつ実際に経験してみて得られた所感や知見を上長から許可もいただいたので雑多に記事にまとめてみます。

注意書き

- ゲーム業界の話です。web業界では色々話が変わってくるところも多いかもしれませんし、同じ業界でも会社によって様々だと思います。

- ここに書いたことが他の環境ではうまくいかないケースも多々あると思います。異論も色々あると思います。状況に合わせたイレギュラーなことも結構やっています。一つの事例程度としてお考えください。

- ポエム成分を含むかもしれません。

集計やETLの全ての処理は冪等性を極力担保する

集計やらETLの対応はツールやサービスのGUIだったり、自前でPythonなどのコードやSQLを書いたりと様々だと思いますが、すべての処理で冪等性が担保できているということが大事です(任意の過去のデータも含め、何度集計などを流しても同じ集計結果になる状態)。

冪等性参考 : 冪等性とは「同じ操作を何度繰り返しても、同じ結果が得られる性質」のこと

基本的には後述するように念入りにチェックなどをするものの、多くの対応をしていると一部にミスが見つかったりも発生しうるものになります。

また、何らかの影響で日々の集計などが一部の処理が通らないといったケースが発生することも、頻繁にはありませんが数か月に1回くらいは発生しています。

そういった場合に過去の日付に対して処理を流しなおしが必要になることもあれば、直近のデータに対して処理を流し直す必要が出てきたりします。

そのようなケースが発生したときに、ごく一部でも冪等性が担保されていないところがあると大分しんどいことになりえます(大半の処理は冪等性が担保されるのが一般的ですが、ごく一部定期処理の中に担保されていないものが混じっているケースなど)。

しっかり気を付けていても大量に処理があると「え、そこで引っかかるの?」といったことも発生しますし、ログ側の都合で巻き込まれる形で流し直しになりうるケースも起こり得ます。

なので処理を書く際には「障害は起きるもの」として対応し、「過去の処理を流し直す場合どのくらいで対応できるだろうか?」といったことを意識しておくといいと思います。

日々のチェックの処理を面倒臭がらずに仕込んでおくと後が楽

データ基盤だと、大半のケースでは時系列的なデータを持つことが大半だと思います。

毎日多くのデータが蓄積されていきます。うちはデータ基盤は各プロジェクト横断的に対応しているので、新しい社内のプロジェクトがリリースされたら増加ペースが早くなります。古いプロジェクトが終了した場合でも過去の分析をしたい・・・という要望を考えると終了プロジェクトのデータも消さずに残す形で運用していきます。

結果としては非常に長期の期間のデータを扱う必要が出てきます。ゲーム業界だとスマホゲームとかだと開発3年、運用5年といった長期にプロジェクトがなるケースも珍しくは無くなってきました(開発費の高騰などの影響も含め)。

そういった状況で、集計などの処理が「後々になってからミスが見つかった」みたいなケースが発生すると、結構対応が面倒なことになります。

特に追加した処理を反映してからミスに気づくのが数か月後とか、年単位で経過していると大分対応に時間が持っていかれるケースがあります(特に利用頻度が低いデータだと、目に見えづらいことも絡んで気づくのが遅れたりします)。

そういったケースをなるべく減らして楽をするために、チェック用のスクリプトなどはしっかりさせておくと後々の負担がぐぐっと減ります。

弊社のデータ基盤の場合、集計処理やETLの多くをPythonとデータサイエンス方面のライブラリに頼っています(ETLなどでBigQueryやAthenaでのSQLを大量に書くといったことは少な目)が、基本的にはほぼほぼの行カバレッジを確保する形で集計処理などに対する単体テストは書いています。

SQLやら外部サービスなどを使う場合でも、ミスしていないかのチェック用にスクリプトを書いたりは大切かなと思います。また、デイリーなどで「集計結果大丈夫だよね?」といったことを確認するための様々なチェック処理が流れるようにしています。

他にも「送っていただいているログ側が何だかおかしいぞ?」といったことのチェックも色々入れたりもしています(なんらか引っかかったらチャットに通知し、早い段階でプロジェクト側に連絡をしたり等ができるようにしています。データソースで問題がありそうであればプロジェクト側の方が気づくよりも先に気づけるくらいが理想)。

加えて集計後のものに対する検算対応であったり、プロジェクトのドメイン知識が浅かったりもするので「この集計結果、違和感ないでしょうか?」みたいなことをプロジェクトに張り付いている分析担当の方に確認していただいたりなど、多重にチェックを入れたりもしていました(プロジェクト固有の数値の感覚は、プロジェクト側の方の方が鋭かったりもするため)。

若干チェックに力を入れすぎ・・・と感じられるかもしれませんが、前述のように長期間経過してからミスに気づくと結構地獄です。

また、修正を入れるときも各プロジェクトへの説明が必要になったり、今までの意思決定が誤った数字によるものになってしまう恐れもあります。

そういったリスクを加味すると、チェックは「やりすぎ」くらいが結局長期的には楽になったりします。なんだかんだそれくらいチェックしていてもミスするときはミスしますが、データ基盤の仕事を始めたころのチェックが甘い時と比べれば大分負担が減っています。

速度は大事

いくらチェックなどを頑張っていても、ミスやエラーなどが発生するときは発生します。

また、途中で追加の要望をいただいたりすることも結構あります。

そのようなケースで数か月、場合によっては年単位の処理の流し直しが発生することも結構あります(特に要望系は障害などと比べると結構多く発生しますし、会社への貢献という面でいうとなるべく要望に対応すべきとは考えています。差し込みタスクとなってしんどい時もありますが)。

流し直しが必要になった時に、冪等性などが担保されていても処理速度が遅いと辛いことになります。

仮に1日分で必要な処理が1分くらいで終わるとしても、1か月分で約30分、1年分で約6時間。

3年分とかの依頼が来ると結構辛いです(一方で案外そういった年単位の依頼は来たりします)。

なるべく楽をするためにも一日分の処理をなるべく速くしたいところです。データレイクやDWHなどは速いものを利用する(BigQueryなりS3なりで)、パーティションの利用などはきっちりとやる、PythonスクリプトやSQLなどで遅くならないように注意する、事前に細かく速度を計測しておく、知らないうちにログが大きくなっているデータセットでパフォーマンス的に問題を抱えていないかなどを継続的にチェックする、アラートの仕組みを整えておくなど、配慮すべき点は様々です。

年経過でPython界隈も色々改善しているライブラリが出てきたりもしていますので、そういった新しいものに少しずつ切り替えていくといったことをすることもあります(PandasやNumPyを良く使っていたコードの箇所で、DaskやVaexを検討するなど)。

諸々の処理のコードなどの保守性も意識する

※注記 : プロダクション環境のスクリプトなどの話となります。例えばJupyterのノートブックなどもそうですが、色々試行錯誤したいタイミングでテストだ、Lintだ、docstringだ・・・と(使い捨てのノートブックなどで)気にするのは非効率なケースも多く、そういったものは以降の節では含みません。

- notebookはあくまでもアドホックな「らくがき帳」「試行錯誤するためのサンドボックス」である*12

- 「よっしゃこれはイケるぞ!」ってなった段階でちゃんとしたプロダクトのコード(テストコードを含める)に落とし込むべき

データ分析者たちのコードレビュー #とは - 散らかったJupyter notebookを片付けるかどうするか問題を考える

集計やETLの処理などは日々増えていきます。弊社の場合、集計以外の内製・補助的なツール部分・施策やRCTの実行など諸々を全て含めるとデータ基盤のプロジェクトがこの記事を書いている時点でファーストコミットから7年目、10000弱のコミット、Pythonのdocstringやテストなども含めたスクリプトが約36万行ありました。

ゲーム業界の各プロジェクトが長期戦がデフォルトな件・且つ弊社の場合データ基盤が各プロジェクト横断的に担当しているため、社内の中でも大分長期プロジェクトになっています(多くのベンチャーが10年未満で無くなることを考えると、1つのプロジェクトで7年って大分長く感じます・・・)。

そうなってくると人の異動なども勿論発生しますし、半年前のスクリプトなどは自分が書いたものでも記憶が曖昧になってきたりもします。他の人からみても自分が後で読み返しても、瞬時に内容を把握できる読みやすいスクリプトやSQLなどである必要があります。

長時間かければ読めるという状態だと、スクリプトやらが膨大になってくると作業効率的に辛くなってきます。なるべく瞬時に理解できるという状態が理想です。

特にデータエンジニアという職種は会社の規模にもよりますが、通常のゲームクライアントのエンジニアさんやweb業界でのフロントエンジニアさん、サーバー・インフラエンジニアさん達と比べると少人数になりがちです。

数人といったケースや、場合によってはベンチャーなどで人数が少ないフェーズでは1人、もしくは専任のデータエンジニアが0人でサーバーサイドの方が兼任というケースも結構あるかもしれません。なるべく人数が少なくても効率良く仕事をさばけるようにすることが大切です。

読みやすいコードにするため、Pythonのスクリプトであればdocstringをしっかりと書く・1つの関数で循環的複雑度(or認知的複雑度)などが高くならないようにしたり行数を短くしたりして、テストなどが書きやすいものを多くする・各種Lintを利用する・型アノテーションを利用する・他の方の事前のレビューを挟むといったことが挙げられます。

データセット(データレイクやDWHなど)であればメタデータをしっかり保守するという点も含みます。

普通のプロジェクトで必要になるものに似たようなものが多めですが、集計やETLのコードでも長く保守するものは同様にコードを綺麗に読みやすくするためのものは可能であれば導入しておくといいと思います。

弊社のケースであれば、以下のようにやっています。

docstring

基本的に全てのコードに対してNumPyスタイルのdocstringを書く形で進めています。

この辺りの書き方は自分でも以前記事にしているので、同僚の方にそちらを確認いただいたりしています。[Python]可読性を上げるための、docstringの書き方を学ぶ(NumPyスタイル)

また、「うっかり書き忘れていた」「コード書き換えていたらうっかり引数などのdocstringがずれていた」といったケースも結構発生します。Pythonスクリプトでテストを基本的に書く形で保守している都合、気軽に変更がデプロイできるのでコードの頻繁な変更も入ったりしており、その分docstringとコードの内実がずれたりが発生しがちです。

この辺りは人の目だとミスを見落としたりしがちなので、本番反映される前にCI的にdocstringのLintを通してからデプロイされていく形で運用しています。

NumPyスタイルのdocstringのLintは要件に合うものが見つからなかったため自作しています。

NumPyスタイルのdocstringをチェックしてくれるLintを作りました。

プロジェクトの途中からこのLintを入れたのですが、docstringの記事を自分で書いておきながらLintをプロジェクトのスクリプトに反映したら自分で書いたコードでも結構Lintに引っかかる点が見つかりました。人の目に頼らずにLintを通る環境にしておくことが大事です(自戒)。

また、複数人で作業する際にもLint任せでdocstringの不足やずれなどのチェックがレビューで不要になったのでその辺りも負担が減って良かったなと思っています。

循環的複雑度(or 認知的複雑度)や行数について

ifやらtry-exceptやらforやらがたくさん入れ子になっていたり、1つの関数やメソッドがとても長いと読むのが大変ですしテストを書くのもハードモードになってきます。

スクリプトだけでなく、他人が読んだり引き継いだりするのが無理ゲーに感じられる複雑なSQLも同様です。

そういったスクリプトを避けるために、循環的複雑度(cyclomatic complexity)という指標があります。

循環的複雑度とは、ソフトウェア測定法の一種である。Thomas McCabe が開発したもので、プログラムの複雑度を測るのに使われる。プログラムのソースコードから、線形的に独立した経路の数を直接数える。

循環的複雑度 - Wikipedia以下の記事が循環的複雑度について分かりやすくまとめていらっしゃいます。

記事にある通りifやらforやらが関数内などで増えていけばその分読むのが辛く、テストなども書きづらくなってきます。体感的には関数1つで複雑度5以下、docstringなどを除いた行数40行以内くらいのものが大半になっていると快適だなぁと感じています。

ただし、テストの書きやすさに関してはprivateのものに対してもテストを書くか / 書かないかによっても変わってきます(publicのものにだけテストを書く場合はprivateのものを細かく関数分割してもあまりメリットが少ないなど)。

privateのものにテストを書くかどうかは、privateのものにテストが書きやすい言語かどうかなども絡んできますし、プロジェクトごとの選択次第でどちらが正解というものでもないと思っています。

Pythonの場合はprivateの場合は関数名やメソッド名の先頭にアンダースコアを付けるだけの運用(Pylanceなどでprivateのものに対してチェックの挙動が変わったりはするものの、実際には外部からはアクセスができます)となるため、テストモジュール側からもprivateのものへのアクセスはでき簡単にテストは書けるので書く形で運用しています。

複雑度の低いprivateのものに細かくテストを書くことで、個々のテストの関数がシンプルになりますし、問題が出た時に問題箇所の特定が素早くできるなどのメリットは享受できています。この辺りはプロジェクトに応じてベストなやり方を選択ください。

弊社プロジェクトの現状ですと明確にLintで縛ったりはしていませんが、ぱっと見で複雑度が高そうであれば直したりレビューでコメントしたりといった形で運用しています(近いうちにLintの導入を検討する、といったissueは登録されている段階)。

Lintなどで運用する場合には循環的複雑度をチェックしてくれるflake8のプラグインなどもあります。

また、JupyterLabなどであればLanguage Server Protocol用の拡張機能などで組み込まれていたりもします。

- Language Server Protocol integration for Jupyter(Lab)

- ついにJupyterLabの入力補完??Tab押さずに補完してくれるjupyterlab-lspを試してみた

また、循環的複雑度よりかはもっと新しいもので、認知的複雑度(cognitive complexity)という指標も存在します。

Cognitive Complexity でコードの複雑さを定量的に計測しよう

たとえば、

if ... : if ... : if ...: for ... : ...といったコードと

if ... : return if ... : return if ... : return for ... : ...みたいなコードでは、循環的複雑度では複雑度が同じですが、人からすると前者の方が読みづらいコードになります。認知的複雑度だと人にとっての感覚に近い形で複雑度がカウントされるので、前者の方が数値が高くなります。

flake8の拡張機能のものも含めて、ライブラリはいくつかPyPI(pip)に登録されています。

各種Lint

弊社のプロジェクトの場合、ETLやら集計などのを扱うPythonスクリプトに関してはコードを綺麗にしたりスタイル統一のために以下のLintを導入しており、一通りのLintを通ってから本番にスクリプトが反映される形で運用しています。

- autoflake -> 使われていないimportやローカル変数などの自動削除

- autopep8 -> 修正ができる範囲での自動のPEP8を準拠する形へのスクリプト変換

- isort -> PEP8に準じる形でのimportの整形

- flake8 -> autoflake、autopep8、isortを通しても引っかかるPEP8の点のチェック

- numdoclint -> 前述のdocstringチェック用

Blackなど含め、他にも色々Lintは世の中にありますのでプロジェクトに合わせて好きなものを選択いただければいいと思います。

PEP8に関しては以前記事を書いているので、そちらを同僚の方に共有したりしています。

[Pythonコーディング規約]PEP8を読み解く](https://qiita.com/simonritchie/items/bb06a7521ae6560738a7)

Lintでどのように更新されたり引っかかったりするのかを日々見ていると、「規約的にどのように書くべきなのか」「このルール間違って認識していた」といったことに気づけて勉強になります。

また、コードスタイルが強制的に統一されていくので、複数人で作業しても似たようなコードになってきて他人のコードでも読みやすくなります(人による癖などが減り、プロジェクト全体で統一感が増します)。

Lintに任せられるところはチェックを省けるので、コードレビューなどでの負担も減ります。

途中からLintを加えていくのもアリ

既にスクリプトなどが稼働中の場合、途中からLintを入れるのに抵抗がある・・・といったケースもあるかもしれません。

弊社のプロジェクトでも、私は途中からプロジェクトに参加しましたが、当時はLintが導入されていませんでした。

各種Lintは途中から入れたのですが、以下のように入れていきました。

- モジュール(スクリプトファイル)単位で、各Lintで有効にするものを設定できるようにします。

- テストの追加が終わっているモジュールに対して、問題が無さそうであればLintを有効にする設定を追加します。

- Lint有効化の設定がされたモジュールのLint反映結果がテストを通ることを確認します。

- テストが無いモジュールに関してはLintの追加を後回しにします。

- ※現在はほぼほぼのテストカバレッジが確保されていますが、当時はテストが無いモジュールもかなり存在していました。

- ※テストが無いモジュールに関しては、Lint有効化よりも先にテストを追加する方を優先します。

こうすることで日々少しずつLint設定が有効化されたモジュールが増えていく形となり、一気にLint反映・・・とならない(小出しに変更が細かくデプロイされていく)ですし、テストを通っているので一層安心して進めることができます。

また、小出しにLintを導入できる形にしたので、新しいLintの追加なども気持ち的なハードルが下がり、複数のLintの導入に繋がっています。

加えて、日々各Lintの有効化されているモジュール数のカバレッジを通知するようにしたり、各Lintで有効化されていないモジュールはどれなのかがすぐに確認できるようにしていました。

少しずつLintのカバレッジが高くなっていく推移を毎日眺めつつ過ごすのも、闇雲に進めるよりも進捗が分かりやすくて気持ち的にプラスに働いた気がします。

型アノテーション

Pythonなどが静的型付け言語ではないので、型を書かなくても動きますが、やはり型情報を書いてリアルタイムにチェックなどが走っていると、事前にミスに結構気づくことができます。

もしPythonなどを結構使われている場合には、積極的に利用するとより堅牢・保守しやすいスクリプトになります。このあたりの型アノテーションは以前記事を書いたり、他の方が書かれていたりするので引用やリンクだけ貼っておきます。

Python は、動的型付けを備えているから楽しいという部分もあるかもしれませんが、全体を見通しにくくなる場合があります。

...

静的型チェックの鍵は、規模です。プロジェクトが大きくなればなるほど、静的型チェックの必要性を感じるようになります(最終的には必須になります)。

...

型チェッカーは大小問わず多くのバグを見つけます。「None」 値などの特別な条件の処理が忘れられているような場合が、よくある例です。

Python の型チェックが 400 万行に到達するまで

- Pythonではじまる、型のある世界

- 入力補完を充実させ、より堅牢なPythonコードのための型アノテーションとPyright入門

- [Python]PylanceのVS Code拡張機能をさっそく使ってみた。

- Pythonで型を極める【Python 3.9対応】

なお、最近の3.9や3.10のPythonバージョンでも色々型アノテーション関係のアップデートが入っています。もしアップデートが現実的な場合には新しいPythonバージョンの方が色々便利だと思います。

データセットのメタデータ

データレイクやDWHなどのデータに対するメタデータ(テーブル説明やらカラム説明やら、データ更新タイミング、補正の入ったタイミングの情報など)の資料の保守は大切です。

普段の作業で資料がないと結構データの把握で時間がかかってしんどいですし、データを誤解して集計をミスするといったリスクも高まります。

新たにアサインされた方のキャッチアップのしやすさ的にも、しっかりログなどに更新が入ったタイミングで資料をアップデートしていくことが大切です。

メタデータの資料が無いと謎のテーブルがたくさん量産されている、削除していいのか判断が難しい、ディスクコスト的に無駄が多い・・・といったことも発生するかもしれません(集計用の中間テーブルなどで)。

この辺りはクラウドサービス側でも用意されていたりもしますし、うまいこと保守できればやりやすい形でいいと思います。ただし共有サーバーにエクセルで資料を置くといった対応は保守されなくなるケースが経験的に多めです(n=4くらい)。

エクセルでの保守が厳しそうであれば、「更新が楽」「開くのに時間がかからない」「ファイルが乱立しない」「検索のUXが良い」「できたらバージョン管理して欲しい」辺りを意識しつつ良さそうなサービスやツールなどを選択するといいと思います。

ごく短時間で更新が終わらせられるといった点が、ちゃんと保守されるかどうかに絡んでくるので検索してすぐ見つかる・すぐ開けるといった点も大事です。

弊社の場合、会社の都合でGCPのBigQueryではなくAWS環境を使っているのです(その辺りは後々触れます)。

Athenaなども利用しつつ、同じデータソースでS3をマウントしたりしてPython(PandasやらDaskなど)でも直接扱えるようにしています(SQLだけでなくPythonを使って色々できると楽なので)。

また、データの扱いもDjangoのORM的に扱え(内部でDaskなどを使いつつ)、モデルを追加する(DWH的なところにテーブルを追加する際など)には「メタデータを追加しないとモデルが定義できない」形にしてあります(且つ、モデルを追加するとAthena側でのテーブル生成やパーティション更新などが自動でされるようにしてあります)。

モデルを指定するとメタデータのマークダウンが出力できるようにもしてあり、これによってDWH環境にテーブルを追加する際にメタデータの追加を忘れるといったことが無い形で運用ができています。

プロジェクトごとの個別のデータ基盤にするべきか?社内横断的なデータ基盤にするべきか?の話

プロジェクトごとに個別にデータ基盤やらBIなどの環境を組むか、もしくは独立したデータ基盤のチームが担当して、各プロジェクト共通の基盤にするべきか?というトピックが話に出ることがあります。

これに関しては様々な意見があるでしょうし、私もいまだに正解がどちらなのか分かっていません。弊社だと横断的に共通基盤で対応しており、個別に作るケースを経験したことがありませんので参考程度となりますが、個人の主観によるメリット・デメリットに触れておきます。

共通基盤にする場合のメリット

ぱっと思いつくもので以下のようなメリットがあります。

- 2個目以降のプロジェクトの対応が楽

- 人やプロジェクトによる些細な集計の違いによるズレが起きづらい

- 他のプロジェクトのログで、まだ試していないものの傾向が調べられる

- 人のプロジェクト異動の際の学習コストを抑えられる

それぞれ細かく触れていきます。

2個目以降のプロジェクトの対応が楽

弊社の場合ゲーム業界なので、各プロジェクトで共通で確認が必要なKPIというものが色々存在します。

それらの集計のコードは各プロジェクトで共通で回してあり、可視化なども含め共通コードで処理されています。

そのため新規プロジェクトの対応依頼が来たときにはデータレイクなどに送っていただいているログを参照してETLを行い、各プロジェクト共通のフォーマットのテーブルを追加するだけで様々なKPIの可視化まで含めたダッシュボードやその他のBIツール上の機能の対応が終わります。楽です。

特にゲーム業界だとリリース直後に広告などを頑張ったりする都合、リリーススケジュールがずらすのが難しかったりするものの、一方でデータレイクのデータ対応が結構リリースギリギリになったりもするケースがあるのでリリース前にさくっと対応が終わるというのは大切です。

また、既に他のプロジェクトで経験を積んだメンバーが他プロジェクトも担当することになるので、「どんなKPIが必要なのか」「どんな作業が必要なのか」「どんなことに気を付ける必要があるのか(リセマラユーザーやらbotやら不正ユーザーやら)」といった点で経験値が溜まっているというメリットもあります。

人やプロジェクトによる些細な集計の違いによるズレが起きづらい

集計などをする方が各プロジェクトで別だと、ちょっとした集計の差やログの差で結果が結構ずれてしまいます。

例えばAプロジェクトではリセマラやbotの判定を〇〇する形でやっているけど、Bプロジェクトでは××の形で集計している、といった類のものです。

密にコミュニケーションを取らないと人によってKPIの細かい定義の差が発生することもあります。

また、密にコミュニケーションを取っていても〇〇のフィルタリングを入れるタイミングがAさんとBさんで微妙に違ったため数値が合わない・・・といったことも発生したりで、ちょっとしたSQLやスクリプトの内容の差でずれたりもします。

このズレは世間が思っている以上に発生しやすく、ぴったり合わせるのは大分骨の折れる作業になります(特に複雑な集計になるほど)。

また、ズレていると会社としての意思決定のミスにも繋がりかねません。

(例 : AプロジェクトはROASの数値が良かったのでAプロジェクトに広告費を多く使ったものの、実はAプロジェクトの方が有利な集計内容になっていて本当はBプロジェクトの方が広告回収効率が良かった等)ズレた時に「なんでずれているの?」と各所から質問が来たりもしますがその説明も結構負担になります。

データエンジニアリソースが不足しがちなことを考えると、この辺りのコミュニケーションコストの負担はなるべく抑えてるためにも、大部分の集計コードやSQLなどは各プロジェクトで共通化できるとズレが少なくできて楽です。

人のプロジェクト異動の際の学習コストを抑えられる

これはまあ・・・会社でツールやサービスを統一すればいい話ではありますが、一方で日頃新しくイケてそうなツールやサービスなどがどんどん生まれているのも事実です。

「新しいプロジェクトでは〇〇を使ってみよう」という話が出るのも良くあることですし、そういった新しいものを積極的に試すことも大切だと思います。

一方で日々忙しくしているブロデューサーの方やプランナーの方からすると、ツールの使い方の勉強時間はなるべく抑えて企画などを考えるのに注力したい・・・という意見もあるかもしれません。

各プロジェクトであまりに使うツールやサービスがばらばらになりすぎると、異動時のキャッチアップが少し大変かもしれません。

共通基盤・共通ツールだとその辺りの学習コストが抑えられますし、過去のプロジェクトでのツール上での設定や記述なども使いまわしたりもすることができます。

ただし古いものを使い続けることになりがちなので、この節の内容に関しては光と闇の両面がありそうです。

他のプロジェクトのログで、まだ試していないものの傾向が調べられる

共通の基盤・同じフォーマットのログデータなどを揃えておくと、リリース前のプロジェクトや未リリースの施策などで、別のリリース済みのプロジェクトの内容や施策結果がどうだったかなどを他部署の方が分析したりといった利用もすることができます。

実際にAプロジェクトの方がBプロジェクトの数値を見たり分析をしたりといったことは弊社でも見受けられます。

すぐに複数プロジェクトで比較したりもできるため、例えば役員の方が横断的に比較したいといったときにさくっと切り替えが出来るなどのメリットもあります。

共通基盤にする場合のデメリット

デメリットの方は以下のものがぱっと思いつきました。こちらもそれぞれ詳しく触れていきます。

- 技術が固定化されがちで、新しい言語やライブラリへのアップデートが大変 / 新しいサービスの利用がやりづらい

- プロジェクトが増えてくると、少人数のチームで回すのが大変になってきそう

技術が固定化されがちで、新しい言語やライブラリへのアップデートが大変 / 新しいサービスの利用がやりづらい

新しいプロジェクトでは過去のしがらみが少ないので新しい技術やサービスなどを試してみる・・・という選択肢が取りやすくなります。

また、プロジェクトの終了に伴い基盤も停止させたりする場合には保守の負担も減ります。

一方で共通基盤とすると、年数経過でデータ量・データの種類・スクリプトやSQL・可視化結果などがどんどん増えていきます。

弊社もたくさんのPythonスクリプトがありますが、動いているそれらを維持したまま新しいバージョンにしたり、古いデータ環境を切り落としてもっと優れて安いものに引っ越ししたり・・・といったことは必要になったりします。中々骨の折れる作業です。

そういった移行作業などの際に前述したテストをしっかり書いているかどうかが結構響いてきます(というよりもテストが無い場合・もしくはカバレッジが低い場合移行が出来る気がしません)。

稼働中のものになるべく障害やダウンタイム的な影響を出さずに切り替えや切り落としなどを進めていく上では、ストラングラーパターン的な対応をしたりしていますが、新規プロジェクトで新しいサービスの利用を進めるケースよりも負担が大きいことは間違いありません。

結果的には共通基盤にすることで基盤の寿命が長くなり、古い部分が結構出てきてしまったり、新しくする人的リソースが確保できなくなる(そこまで手が回らない)可能性は出てきます。

便利そうなツールやサービスは新しいものがどんどん出てきていますし、同じクラウドでも新しいサービスが日々出てきています(特にAWSはサービス多すぎ感が強い)。

もしくはプロジェクトの海外展開で、中国展開が必要だけどGCPの中国リージョンが無いからAWSにしようとか、逆に今後はGCPの便利な機能を使ってGCPメインにしていこうとか、Office関係と連携を楽にするためにAzureメインにしようといったようなクラウド自体の引っ越しも起こり得るかもしれません。

BigQueryだけGCP、他AWSみたいな選択は多いと思いますが、会社の管理面などの都合でマルチクラウドではなくAWS/GCPどれかに統一しようとかそういった選択をする会社もあると思います。

これらを加味すると、切り替えや新しいものの利用が気軽にできないというのはデメリットに感じます。

プロジェクトが増えてくると、少人数のチームで回すのが大変になってきそう

複数プロジェクトを横断的に対応していると、質問や要望などで多方面からチャットが飛んできます。

各プロジェクトのプロデューサー・ディレクター・プランナーの方々からの質問や要望であったり、マーケの方からのものだったり、役員の方からの質問や依頼だったり、各プロジェクトのエンジニアさんとのやりとりだったりと様々です。

プロジェクトが増えてもデータエンジニアが増えればまあ何とかなるかもしれませんが(あまりに人数が多くなったらチーム分けたりは必要になるかもしれませんが)、基本的にはプロジェクトが増えたタイミングでデータエンジニアが増えたり・・・はしないことが多いと思います。基本的には今の人的リソースで何とかするといったケースが多いと思います。

また、プロジェクトが増えなくても日々データが積みあがって増えていったり、集計のスクリプトが増えていったりもします。

今の所私はほとんど残業せずに、有給などもしっかり取る形で過ごせていますが、今後のプロジェクト増などで状況が変わってくる可能性もあります。負担が各プロジェクトに分散せずに、共通基盤部分に集中していってしまうというのは一応デメリットではあるかもしれません。

使い方研修をしなくても色々な人に使ってもらえるUIを目指す

話は変わってUIなどの話です。元々デザインの学校を出てデザイナーのお仕事をしたり、ゲームのクライアントエンジニアをしていて「演出こだわるの楽しい!」といった経歴なので、弊社の場合BIツール部分が内製になっておりUIや見せ方にこだわるのは楽しい作業です(ちなみに同僚の方も元ゲームクライアントの方でセンスが凄いという・・・)。

BIツールが使いづらいUIだと中々社内の利用率が上がってくれません。研修などをして使い方を覚えていただく・・・というのも良いのですが、入社や退職などによる人の異動もあり頻繁に研修を入れるというのも、人数の少ないデータエンジニアで回そうとすると大変です。

UI面では以下のような点を意識しています。

大事な各プロジェクト共通の様々なKPIのダッシュボードはページを開くだけで理解・利用できるようにする

なんだかんだ重要なKPIダッシュボードは開くだけで大半を理解できて利用できる状態が理想です。

なんでもかんでも詰め込めばいいというものでもありませんし(大事なデータが見えづらくなる等の面で)、逆に足りなくて俯瞰しづらいといった状況も良くありません。

皆さん日々忙しくお仕事されているので、1ページで色々大切な数字や可視化部分が過不足なく俯瞰できることが大切です。

このダッシュボードは利用率が高く、職種も様々な方がアクセスしています(役員・プロデューサー・ディレクター・プランナー・マーケ・エンジニア・デザインナー・バックオフィスの方など)。

探索的にデータを深堀りしたり分析したりされている方も勿論いらっしゃいますが、利用率的にはここがやはり大きいのでしっかり力を割くべきところでもあります。

分かりやすく、見えやすいデザインのUIにしたり、統一感のある配色にしたりなどこだわりたいところです。また、定性的な感覚になってしまいますがあまりにデザインが古臭すぎてもよくない気がする(ユーザーからしたら、このツールは技術力的に信用できるのか・・?と感じられてしまったり)のでその辺りも初心者っぽい作りに見えないようにある程度はしっかりしておきたいところです。

非デザイナーの方でも、ノンデザイナーズ・デザインブックといった昔からあるロングセラー本も含め色々本が出ていますしそういった領域を学んでみても面白いかもしれません。

また、会社によってはカラーユニバーサルデザイン的に可視化の配色をこだわったりも有益かもしれません。

この辺りはGoogleの方が書かれたStorytelling with Data: A Data Visualization Guide for Business Professionalsとかのベストセラー本なども参考になるかもしれません(ちなみにノンデザイナーズ・デザインブックに出てくるような内容はこちらにも出てきます)。

国内だと先日バズっていたGoodpatchさんの決算資料に対する記事の【パワポ研の決算資料探訪①】Goodpatch社の決算説明資料はシンプルが故に美しいなども良くできていて素敵で参考になりました。

複雑な機能でもなるべく分かりやすくするように頑張る

ダッシュボードだけでは勿論不足していて、データを深堀りしていったりが必要な方々もいらっしゃいます。

そういった方のために、SQLやスクリプトを書かなくてもGUI操作だけで色々条件を変えて集計したり自動でマスタ連携してくれたり、さくっと可視化したりが出来るようにしてあります。

Metabaseのクエリビルダー的なものに少し傾向が近いかもしれません。OSSのデータ可視化ツール「Metabase」が超使いやすい

一方で、ページを開けば使えるダッシュボードとは異なり設定のUIはどうしても多くなってしまうので、ユーザーにとっては使いづらくなってしまいがちです。

そのため、なるべく使い方研修やらを入れなくても使えるように、各UIにマウスオーバーするとヘルプを表示してくれたり、詳細なヘルプも各UIパーツの右上のアイコンをクリックすれば表示できるといったように「なるべくヘルプを身近な存在にする」という点は意識しています。

別ページで長々とヘルプのページを追加する・・・というのも悪くはないのですが、検索で探したり他のページに遷移したりに時間がかかるのも良くありませんし、大抵の場合皆さんご自身の仕事を忙しく担当されているので、ヘルプが遠いと大抵のケースで読まれません。

ヘルプが読まれないと質問がデータエンジニアに飛んできて良くありません。その辺りはなるべく親切に・・・というところは心がけています(まだまだ改善点は残っていますが・・・)。

また、年数経過で、様々な要望などに対応していった結果UI要素が増えていって初見のときの難しさなどを招いたりもするので、BIツールの各機能の利用状況などを確認して使われていない機能の切り落としを行ってシンプルにするという対応も大切です(分析基盤自体の分析と改善を行ったり等)。

日本語のUIは意外と馬鹿にできない

会社にもよりますが、BIツールのUIが日本語で、お知らせやヘルプもしっかりと日本語で確認できるといったことは社内の利用率を上げる上で大切かもと思っています。

エンジニアとして仕事をしていると「UI別に英語でもいいよね」と感じてしまいがちですが、非エンジニアの方がユーザーとなるため、ユーザーフレンドリーという面でいうとできたら日本語UIのものだと利用率の改善的にいいかなという印象ではあります(英語でよく分からないUIがあると敬遠されがちになったり等)。

各部署の方が英語に抵抗の無い方である会社であれば特に意識する必要はありませんが、そうでは無い場合は日本語対応しているツールやサービスを検討するというのもいいかもしれません。

なるべく社内の利用者の方の要望をスピード感を持って反映していく

BIツール部分などを内製している都合、機能やデータなどに対して要望をいただくことも結構あります。

差し込みタスクになったりするのでしんどい時もありますが、そういった要望を出してくださる方は結構ヘビーユーザーになってくれたりするのでなるべく要望に答え、スピーディーに対応していきたいところです(数か月後に対応などだと遅すぎで、施策などのためにすぐ欲しいといったケースも結構あります)。

外部のOSSやらサービスだと中々すぐに変更を加えたり要望を受け入れてもらったりは難しいケースも多いと思いますが、この辺りが素早く対応できるのは内製の強みではありますし楽しさでもあります。

ライトなものであれば要望をいただいてから数時間で、コードを書いてLintやテストなどが通るのを確認して本番反映・・・とできることもあります。

弊社も例に漏れずごく少人数のデータエンジニアのチームで回していますが、細かくアップデートで1日平均3デプロイくらいはしているのでペース的には悪くはないかなという感じではあります。

この辺りのデグレなどを抑えつつ長期プロジェクトでスピード感を落とさないためにもテストやLintの仕組みの有無が響いてきます。

SQLをユーザーの多くの方に学んでもらうのは正解か分かっていない

データの民主化、素晴らしい事だと思います。各社員がSQLを書いて分析するというのも素敵に思います。クックパッドさんみたいにデザイナーも分析するといったケースや、ワークマンさんの各社員が分析のスキルを身に付けるというのもいい話に思います。

他にも、社内の方からも「プランナーがSQLなどで分析できるようになってスキルアップすることは良いことだ」という話も聞いて、そういったところは特に反対意見も違和感もありません。

一方で、全員がSQLを書けて分析が出来るものを目指す・・・というのも100%正しいとも限らない・・・という所感も最近しています。

きっかけはとある社内のディレクターの方がおっしゃっていた「退職や異動などでSQLやスクリプトを引き継ぐのが厳しいので今後はGUI完結で進めていきたい」というものになります。

たしかに普段からSQLやらスクリプトやらを書いている私でも複雑なSQLやスクリプトなどを引継ぎで渡されてしまうとちょっと辛いと感じることもありますし、普段SQLを書かれていない方からすると引継ぎなどが大変そう・・・というのは想像できます。

そういったことを加味して「BIツールはGUIで自動化など含めなるべく完結できるようにしようか・・・」という気持ちが強くなっています。

エクセルで複雑で謎のスクリプトなどが組まれていて、作った方は退職済みだけど触らないといけない・・・とかに似たようなケースと言えるかもしれません。

以下の記事も参考になります。

みんなSQLが書けることを自慢している会社もあるけれど、本当にそれでいいのだろうか

データの民主化が悪と言うつもりはなくて、「何となく良さそうだから中途半端に手を出す」というのがあまり良くない結果になるかも、という印象です。

データの民主化を進めるにしても、

- ちゃんと業務時間でしっかり研修を(場合によっては復習として繰り替えし)やる余裕がある会社

- 保守の難しい謎のSQLが大量生産されないようにしたり、集計ミスを減らすためにSQLレビューのプロセスなどを整備する

- 会社の評価や昇進などの面で、SQLや分析などのものを組み込む

辺りがしっかりとしているといいかなぁと思っています。環境やら制度やらが整っていないと、Redash環境とかを整備しても中々社内利用が進まないかもとは社内で話しています。

AWSのデータ基盤もそこまで悪くはない

世の中の多くのケースではGCPのBigQueryを使うケースが多いと思いますが、弊社データ基盤は大人の都合(他の社内のプロジェクトがほぼAWSで統一されていたり等)でAWSで組まれています。

個人的にはGCPのBigQueryなどのサービスの本もAWSのAthenaなどの本も当時両方読んで、AWSとGCPのイベントもそれぞれ参加はしていたので、BigQuery推しではありましたがどちらでもOKという感じだったところ、各プロジェクトがほぼAWSだったので分析基盤もAWSを利用して組まれる流れとなりました。

データレイクやDWH(データマート)などはS3で、AthenaでSQLを投げたりS3をマウントしてPandasやDask(Vaexなどの利用も検討中)などで利用したりもしています。

世間的には「とりあえずBigQuery」という印象も受けますし、それも正解だと思いますが、実際にAWSで何年か運用してみたところまあAWSでも普通に回せるな・・・という印象は受けています。

Lake Formationなどの便利そうなものもAWSのイベントで結構目につくようになってきましたし、S3のアップデートなども結構入っています。国内のゲーム会社さんの事例でも、SageMakerなども目立ってきました。

Athena(S3)などは圧縮後のデータサイズでコストが扱われる(ディスクコストも、クエリスキャンコストも)形ですし、楽をするためのライフサイクル関係のアップデートなども出てきています。Pythonで扱うためにバイナリ(HDF5やParquetなど)を置きやすいというのも便利ではありますし、データ消失などのリスクに関してもS3のイレブンナインの耐久性と長い歴史というのは信頼が置けます。

なにより、少し前に開催されていたAWSのイベントで知りましたが、フォートナイトやPUBGなどの分析基盤もAWSというのは安心できます。

※日本だとモンストやFGO、ポケモンGoなどの方が知名度があるかもしれませんが、2018年や2019年の世界のゲーム売上だとトップの方で、ユーザー数も膨大(ログの規模もきっと恐ろしいレベル)です。

まあでも自由に選ばせていただけるならBigQueryを選びそうな気がします。エクセルなどの非構造化データをETLなどで扱うのは結構辛い

仕事の大半の扱うデータに関しては処理しやすい構造化データです。

一方で、社内でコントロールがしにくい契約先の企業から送られてくるレポートなどがエクセルなどのフォーマットになっているケースがありました。

一応PythonなどでもエクセルやらPDF操作用のライブラリも色々ありますが、実際やってみると大分しんどかったです。というのも、会社ごとにフォーマットがばらばらで、同じ会社からのエクセルレポートでもフォーマットやファイル名・シート名がばらばらだったり、データが開始する箇所がばらばらだったり・・・と、やってみると分岐される条件が膨大になりました(且つ、すでに年単位でエクセルファイルが大量に溜まっていたりが発覚したりと・・・)。

結局、手を出したはいいもののかなりの労力が必要になりましたしETL対応している間に契約が終了になったりと、辛い経験だけで終わりました。

非構造化データのETLなどは安請負せずに相当な覚悟を持って受けるべきだなと反省しました。

基盤の利用状況のアクセスログを取っているとモチベに繋がる

データ基盤自体が他のプロジェクトのログを使って分析する環境ではありますが、分析基盤自体の社内の方の利用状況などもログを取って色々見てみるとプラスになることがあります。例えば以下のようなメリットが挙げられます。

- どの機能がよく使われているのかが分かるので、注力すべき点が分かる。

- 逆にどの機能があまり使われておらず、切り落としてUIをシンプルにできそうかが分かる。

- 利用者の増加や色々な部署の方が使ってくれたりしているのが分かり、闇雲にデータ基盤やデータ整備の仕事をしているよりもモチベが維持しやすい。

基盤やBIツール環境も整えて終わりではなく、ログを見て常に改善のサイクルを回していけたらいいなと思います(気合を入れてダッシュボードなどを用意しても、全然利用されないと辛いですし)。

施策とかにまで手を出せるといいかもしれない

データエンジニアリングの領域では無い気もするのですが、以前の上司の方が色々部署間の調整をしてくださったり改善の指摘をしてくださったり、同僚の方がAWSでの連携などを対応してくださったりして、分析基盤から社内のプロジェクトに対して施策が実行できるようにしたりも比較的最近のアップデートとして入ったりしました。

アプリ側のアップデート無しで「RCT(ABテスト)での施策実行」 → 「ログ蓄積」 → 「MCMCなども使った効果の色々な可視化」といった一連のものを基盤環境で完結できるようにしてみたりしたのですが、結構試験的なものでしたが案外アリだなという印象を受けました。

RCT実施の前には連絡を入れたり社内プロジェクト側の方に確認と許可をいただいたりは必要ですが、多くの領域をコントロールできるようになると機動力高く対応できたりして快適に思います。

これが複数部署絡んで部署間の調整がたくさん必要になったり、アプリ側のアップデートが必要にすると敬遠されてしまったり(皆さん忙しいですし)と大変です。

且つ、最終的にはRCT的に明確に数値改善の効果が出たりもした(何度も何度も調整したり変えたりは必要になりましたが)ので、数値が出ると後々の説得などをするのもやりやすいかなぁと。

外部の部署のメンバーが分析などをしても「分析・提案したけど施策や実験まで中々落とし込んでもらえない」「分析が無駄になってしまった」みたいなケースは結構あると思っていまして、逆にプロジェクト内の方だと「エンジニアリングにあまり詳しくない」とか「分析にそこまで精通していない」といったケースもあると思います。

そういった面でも施策まで全部セットでコントロール下におけるというのは今後も少しずつやっていきたいところです。

古いシステムへの敬意を

社内の分析基盤関係のプロジェクトが7年目とかになっていますが、それだけの年数があると、初期のころのものなどが結構長期的に悪影響を出したりといったケースも結構あります。

私の方も途中からの参加・引き継ぎだったので結構苦い思いもしています。前任の方が部署にいない状態で、一人情シスならぬ一人データエンジニアで対応しないといけないといったケースを体験して、ブラックボックス化しているものも苦労しつつも色々触ってきました(今は幸い、凄腕の同僚の方に恵まれています)。

しかしながらこれだけ長いこと(社内の中でもトップレベルに長いのではという印象)使われてきたというのは素晴らしいことですし、「如何にしてなるべく安全に改善していくか」といったところなども含めとても勉強になっています(中々できない経験だなと)。

どうか先人を否定しないようにしてください。その開発者は無茶ぶりされながらも奮闘した新人だったかもしれませんし、その頃には今となっては周知のベストプラクティスが存在しなかったのかもしれません。何より「役に立たないコードより、役に立つクソコード」は一つの真実です。

ブラックボックス化したデータ基盤を作りなおすことを決意した貴方へここまで長期に続いてることに敬意を表しつつ、たくさん問題があるということは改善し放題です。諸々を新しくしたりより良くできたりすると中々嬉しいですし楽しいので、案外そこまで悲観しなくてもいいのかもしれません。

※比較的ポジティブにお仕事ができているのは、技術とコードのところや仕事の進め方などの選択はほぼほぼ裁量があるという環境なのも大きいかもしれません。

データエンジニアの仕事を担当してみて、大分成長できた気はする

データエンジニアチーム、社内の中では少人数のチームになりがちです。少人数だと自分で色々な分野を扱わないといけなくなります。

弊社の場合エンジニアでも申請すればCreative Cloudなどは使わせてくれるのと、BIツール部分などは内製していたりするので、デザインツールを扱って自分達でデザインカンプを作ったりお洒落にしたりまでしている(これはこれで楽しい)ので、その辺りまで含めれると大分広い技術を扱っている気がします。書きだすと今の所以下のような感じでしょうか。

- Linux関係(CentOS・Ubuntu)

- Python関係

- Python界隈のライブラリ(NumPy・Pandas・Dask・matplotlib・Jupyter・scikit-learn・PyMC・Django・たまにディープラーニング方面のものなど)

- webサーバー関係(Nginx・gunicornなど)

- Docker関係

- クラウド関係(AWSメイン・稀にGCP。S3・EC2・Athena・Aurora(移行検討中)・Firehose・etc)

- DB関係(RDS・NoSQL)

- HTML・CSS・jsなどのフロント関係(古いのでTypeScript移行検討中)。D3.jsなども。

- CI/CD周りのツール群

- 監視系のツール群

- Adobeを中心としたデザインツール

担当するまではゲームのクライアントエンジニアなどをしていてサーバーサイドやらインフラ周りなどは別のエンジニアさんが担当してくださっていたので、一人データエンジニア担当になった時には「Linux聞いたことはあるけど(言葉通りに)ナニモワカラナイ」「Django?なにそれ美味しいの?」状態でした。

※当時はDjangoの和書もほとんどないタイミングでした。人間、必要に駆られるととても成長できるような気がしていて、デザイナーからエンジニアのお仕事をし始めたころもそうですが結構知らないことが多い領域に飛び込んでみるのもたまにはいいなと思いました。

気が付いたらPython関係は大分詳しくなった気もしますし、Qiita関係もたくさん勉強でアウトプットしてこれた気もします。

自分で色々な技術を触れるというだけでなく、独立部隊としての側面が強く技術選択なども自分達に裁量が結構あります。

他にも朝の始業前に諸々の膨大なデータに対して大量の処理をなるべく落ちずに安定して流れきっている必要があったりと、パフォーマンスやプチSRE的な(あくまでライトな範囲ですが)ところも必要になったりもします。

データエンジニアリングだけでなく、ビジネス的な知見もある程度身に付いたり、データサイエンス方面もある程度勉強する機会に恵まれたりもしています。

この辺りはデータ界隈で有名なゆずたそさんも記事にしていらっしゃいますが、私も同感なところもあり色々技術的にチャレンジができたり勉強すべきところが山ほどあるというのは楽しいし合っているかもなぁとは思っています。

趣味開発ではなかなか接する機会のない規模のデータを捌くことになります。 ISUCONでのパフォーマンスチューニングや、アドテク・動画配信の基盤担当者に近いモチベーションかもしれません。

「多少作りが悪くても動けば良し」というわけにはいきません。 それゆえか少数精鋭チームで技術力の高い人たちが集まっているように思います。

データ基盤エンジニアの面白さ地味で泥臭い面も多々あり向き不向きはあると思いますが、個人的にはデータ基盤のお仕事も中々いいなぁという所感です。

長期の開発・保守を担当してみて

頻繁に転職したり新しいプロジェクトに異動させてもらったりも(実際に過去に異動などを何度か経験してみて)学べることは色々あると思います。

一方で、長期的にプロジェクトをどんどん良くして、Developer Experienceを高めていくというのも面白いなぁとここ最近感じています。

少人数のチームということもあり、良くない実装や保守しづらいものを追加してしまうとそのままダイレクトに自分に帰ってきます。

和田卓人さんのスライドでも触れられているように、長期プロジェクトで深くまで携わって改善や機能追加などを対応していくという選択もアリなのかなと。

今後考えていること

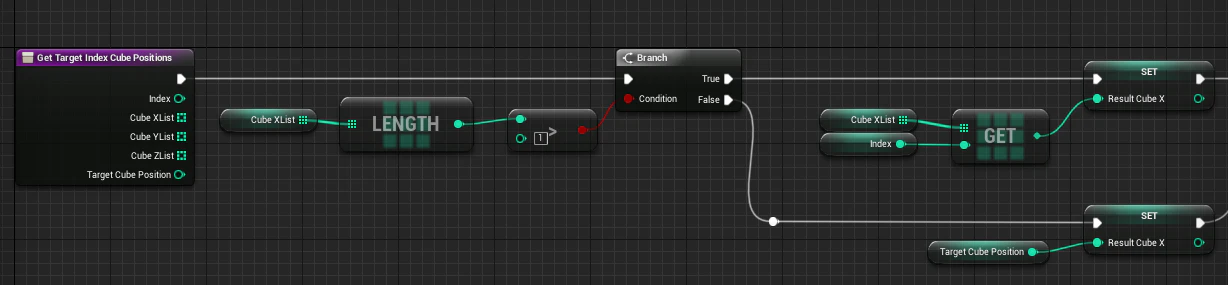

データの民主化をして複雑なSQLやスクリプトが量産されると保守がつらい(それに、非エンジニアの方の学習コストを抑えたいという声も聞いたりしているのでGUIベースでなるべく完結できるようにしたい)一方で、分析の柔軟性も確保したい(ただし現状のGUIベースだと結構辛い)ので、将来的にUnrealEngineのブループリント的なビジュアルスクリプティングで柔軟且つ設定が分かりやすくシンプルなものの機能を追加したいな・・・と考えています。

ブループリント例 :

AzureMLのようなものが近いかもしれません。

AzureMLは機械学習をこれから勉強する人にとって最高の環境だった

余談

勢いに任せて色々書きましたが、色々賛否両論あると思います。自身の知識も経験も足りておらず、いまだに色々試行錯誤している感じは否めないのであくまで参考程度にお願いします。

- 投稿日:2020-11-13T19:32:17+09:00

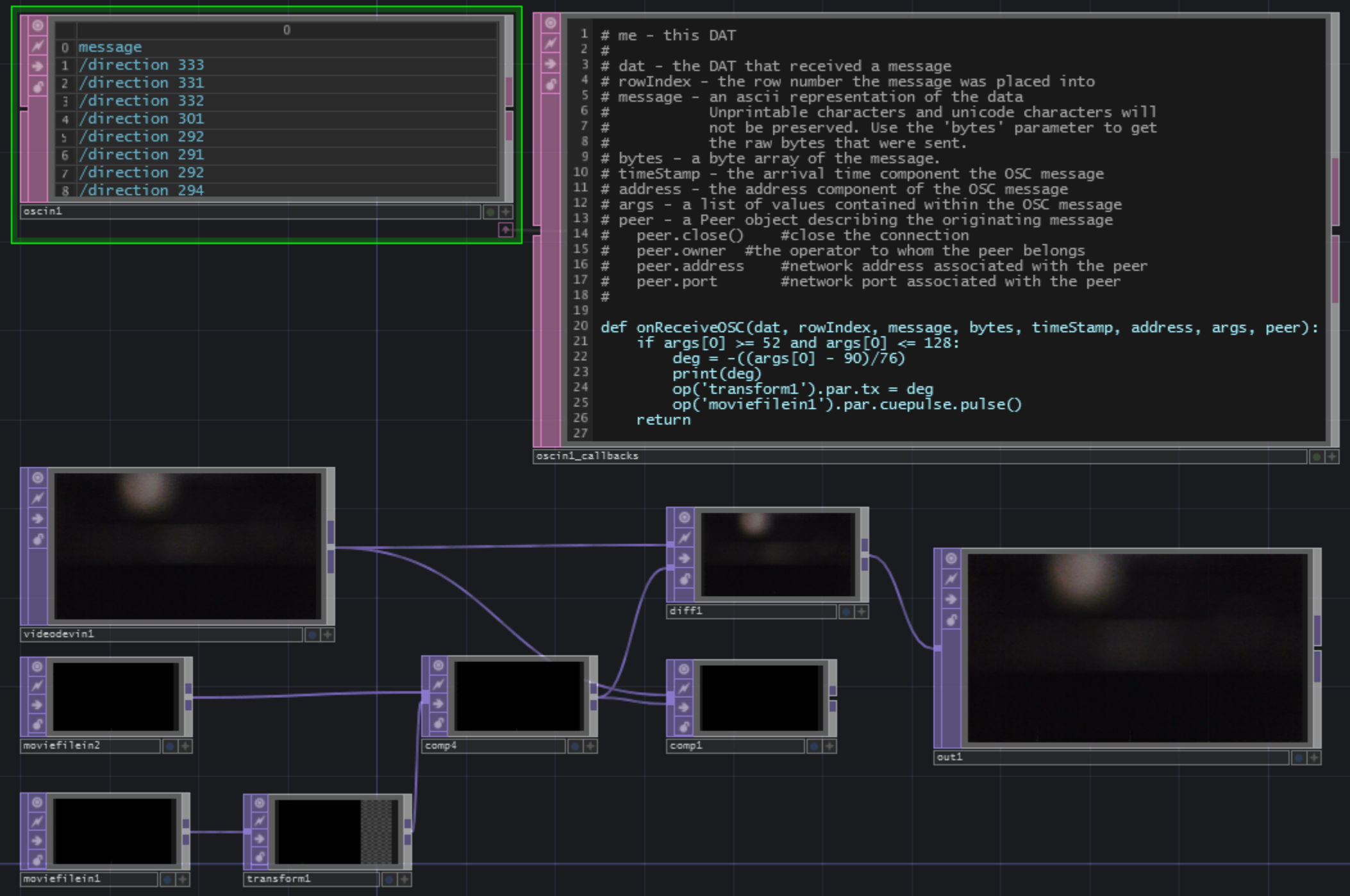

TouchDesignerとReSpeakerで音カメラを作った話

TouchDesignerの学習のため、ReSpeakerを使って音カメラを作った。

ReSpeakerでSSL(Sound Source Localization)を行い、音の到来方向へエフェクトを入れることで、音を可視化したらおもしろいかもしれないと思って製作した。

これを音カメラと呼ぶことにした。TouchDesigner側

これはずっと悩みだったんですが、こういうビジュアルプログラミング系の製作物って、Qiitaでどう共有したら見やすいんですかねぇ…?

とりあえず今回は画像で行きます。内容はいたってシンプルです。

videodeviceinでカメラからの画像を読みこみ、そこに以下のようなgif画像を位置を指定して重ねているだけです。

SSLは生のPythonでやっているので、そのプロセスから結果をOSCで受けています。

ReSpeaker側

ReSpeakerはv2.0を使いました。1.0も持っていて、そっちの方が精度でそうなんですが、何故か手元のWindows10で接続できなかったため断念しました。以前はつながったのに…

ReSpeaker v2.0

https://github.com/respeaker/usb_4_mic_arrayこちらのライブラリから、DoA(Direction of Arrival)というのを行っているところから、音源方向の値のみを抽出してOSCで送信します。

ファームウェアの書き込みとかで結構ハマるので注意。

因みに、今回はPython側でやっていますが、マイクアレイ単体でも音源方向のLEDが点灯するので、デバイス側でも音源方向の推定はやっている模様。