- 投稿日:2020-07-28T23:15:25+09:00

【Python】Pyroでベイズ推定

最近確率的モデルを扱うPyroを知り、面白そうだと思ったので、お試しとして触ってみました。

本記事は、そのソースコードの共有となります。ソースコードはJupyter Notebookで書いています。

理論的な説明はほぼありませんが、ご了承ください。

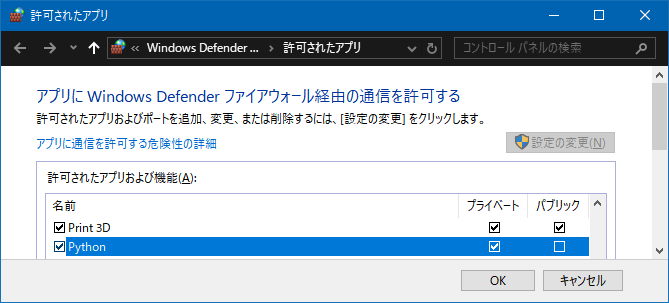

環境

Windows10

Python: 3.7.7

Jupyter Notebook: 1.0.0

PyTorch: 1.5.1

Pyro: 1.4.0

scipy: 1.5.2

numpy: 1.19.1

matplotlib: 3.3.0Pyroとは?

Pyroは、Pytorchをバックエンドにした確率的モデルを扱うライブラリです。

pipからインストールできます。pip install pyro-pplこのとき、事前にPytorchのインストールが必要です。詳細は公式ページをご参照ください。

試しに動かしてみる

今回は、ベルヌーイ分布$Ber(p)$に従うデータから、そのパラメータ$p$を推定することを考えます。

まず、必要なモジュールをインポートします。from collections import Counter import numpy as np import scipy.stats as stats import matplotlib.pyplot as plt import torch import torch.distributions.constraints as constraints import pyro import pyro.distributions as dist from pyro.optim import SGD, Adam from pyro.infer import SVI, Trace_ELBO %matplotlib inline pyro.set_rng_seed(0) pyro.enable_validation(True)データの生成

乱数でデータを作成します。このとき、型をPytorchのtensorにする必要があります。

obs = stats.bernoulli.rvs(0.7, size=30, random_state=1) obs = torch.tensor(obs, dtype=torch.float32) obs> tensor([1., 0., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 0., 1., 1., 1., 1., 1., 1., 0., 0., 1., 1., 0., 0., 1., 1., 1., 0.])データ中の1の個数を確認します。

Counter(obs.numpy())> Counter({1.0: 23, 0.0: 7})よって、パラメータ$p$の最尤推定量は$23/30 \fallingdotseq 0.77$です。1

以降、$p$をベイズ推定していきます。事前分布の設定

ベイズ推定では、パラメータの事前分布を仮定し、観測したデータを合わせて事後分布を求めます。

ベルヌーイ分布$Ber(p)$のパラメータ$p$については、事前分布をベータ分布を仮定するのが一般的です 2

Pyroでは、modelメソッドで事前分布とデータのモデルを記述します。def model(data): # 事前分布を仮定 prior = dist.Beta(1, 1) # データのモデリング p = pyro.sample('p', prior) for i in range(len(data)): pyro.sample(f'obs{i}', dist.Bernoulli(p), obs=data[i])今回は$Beta(1, 1)$を仮定していますが、実はこれは一様分布と一致します。

事後分布の設定

guideメソッドで事後分布を記述します。事後分布も、事前分布と同様にベータ分布とします。

このとき、事後分布のパラメータとして適当な初期値を与えます。def guide(data): # 事後分布の定義 alpha_q = pyro.param('alpha_q', torch.tensor(15), constraint=constraints.positive) beta_q = pyro.param('beta_q', torch.tensor(15), constraint=constraints.positive) posterior = dist.Beta(alpha_q, beta_q) pyro.sample('p', posterior)この事後分布のパラメータ$\alpha, \beta$を求めることになります。

事後分布のフィッティング

事後分布のパラメータの推定方法について、今回は確率的変分推定を採用します。Pyroではこの方法を使うのが基本のようです。

今回のベルヌーイ分布の例では解析的に事後分布を求めることができるため、変分推定のような近似手法を用いるのはナンセンスですが、練習ということでこの方法を使ってみます。

(本来は、解析的に分布を求めることができない場合に使う手法ですね。)NUM_STEPS = 2000 optimizer = SGD(dict(lr=0.0001, momentum=0.9)) svi = SVI(model, guide, optimizer, loss=Trace_ELBO()) pyro.clear_param_store() history = { 'loss': [], 'alpha': [], 'beta': [] } for step in range(1, NUM_STEPS + 1): loss = svi.step(obs) history['loss'].append(loss) history['alpha'].append(pyro.param('alpha_q').item()) history['beta'].append(pyro.param('beta_q').item()) if step % 100 == 0: print(f'STEP: {step} LOSS: {loss}')> STEP: 100 LOSS: 17.461310371756554 STEP: 200 LOSS: 18.102468490600586 (中略) STEP: 1900 LOSS: 17.97793820500374 STEP: 2000 LOSS: 17.95139753818512ここで、

historyにフィッティング中のLoss、事後分布のパラメータ$\alpha, \beta$を記録しています。

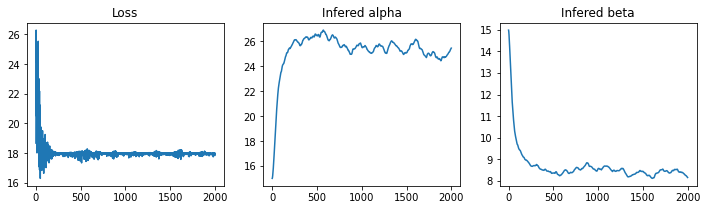

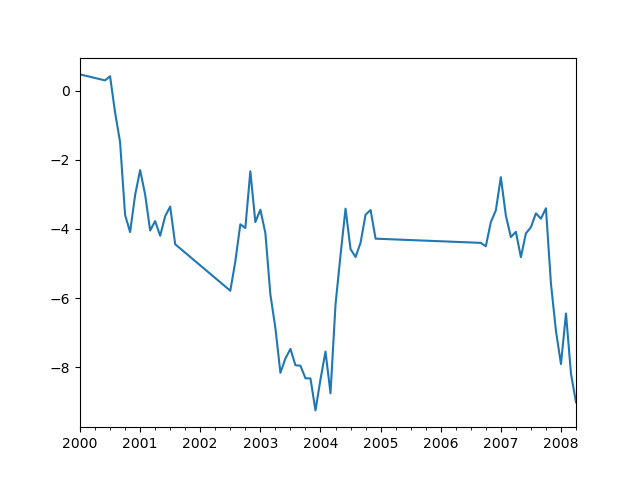

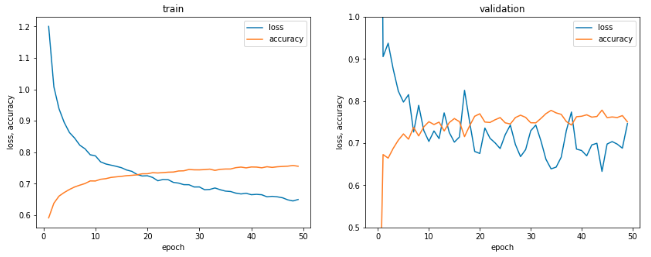

ステップごとのこれらの数値をプロットすると、次のようになります。(ソースコードは省略します。)最終的に得られた$\alpha, \beta$を確認し、事後分布の期待値、分散を確認します。

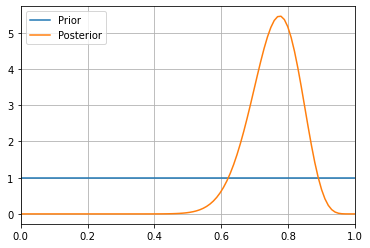

infered_alpha = pyro.param('alpha_q').item() infered_beta = pyro.param('beta_q').item() posterior = stats.beta(infered_alpha_beta, infered_beta_beta) print(f'alpha: {infered_alpha}') print(f'beta: {infered_beta}') print(f'Expected: {posterior.expect()}') print(f'Variance: {posterior.var()}')> alpha: 25.764650344848633 beta: 7.556574821472168 Expected: 0.7732203787899605 Variance: 0.005109101547631603事前分布と事後分布をプロットしてみます。(ソースコードは省略します。)

うまく推定できていそうです。

まとめ

Pyroを使って簡単なベイズ推定を実行してみました。

今回は単純なベイズ推定でしたが、複雑なモデルを柔軟に、かつシンプルに記述できるのがPyroの強みかと思います。

公式ドキュメントには多くの確率的手法の例が載ってあり、これらを眺めているだけでも勉強になりそうです。

- 投稿日:2020-07-28T20:46:51+09:00

高卒工場勤務が未経験から転職するまで(Prologue)

自己紹介

はじめまして!高校卒業後→地元の工場へ就職→現在転職のため学習中

はい。こんな感じで何にも学歴も良いわけでもなく何も取り柄がないわけですが、

転職を考えております。技術で勝負するしかないのです。Qiitaになぜ投稿し始めたか。

これは単純にアウトプットする場所が欲しかったからです。

これから少しづつアウトプットしていきます。とりあえず触ってみた技術、言語

HTML,CSS,JavaScript,Python,Django,Vue.js

とざっくりこのあたりを触りましたが、エラーを吐かれすぎて挫折仕掛けていました。これからどうしていくのか

エラーを吐かれて解決できずに止まることがモチベーションが下がり気味

スクールに通うか迷いましたが、闇が深すぎて断念

様々な人に聞いたところMENTAを使ってみてはどうかということで、

メンターさんについてもらうことにしました。

これからはもう少し効率的に進めていけたらと思います。

- 投稿日:2020-07-28T20:10:46+09:00

天気図をクラスター分析してみた

はじめに

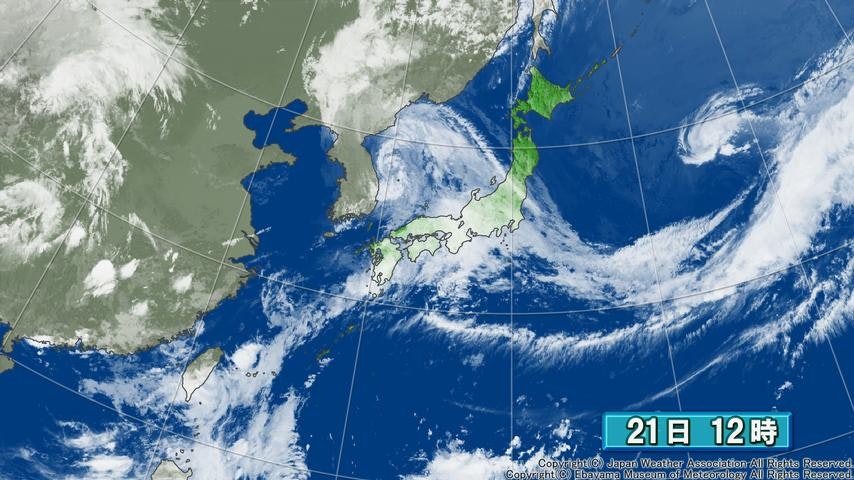

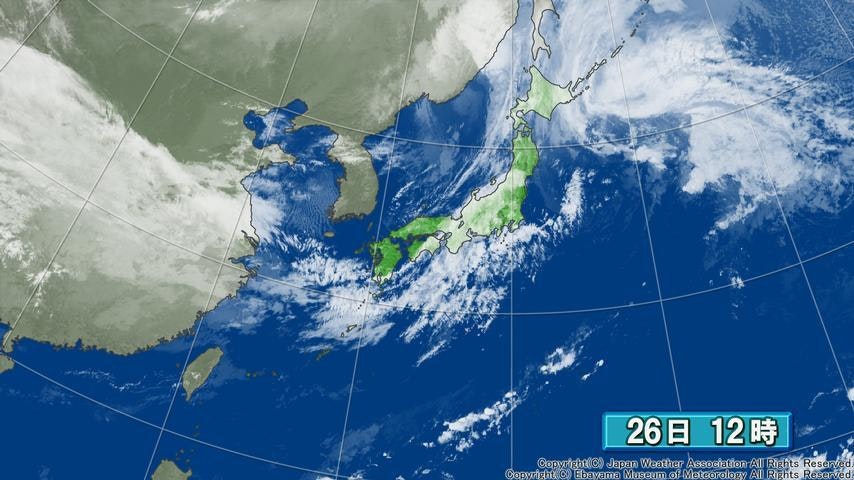

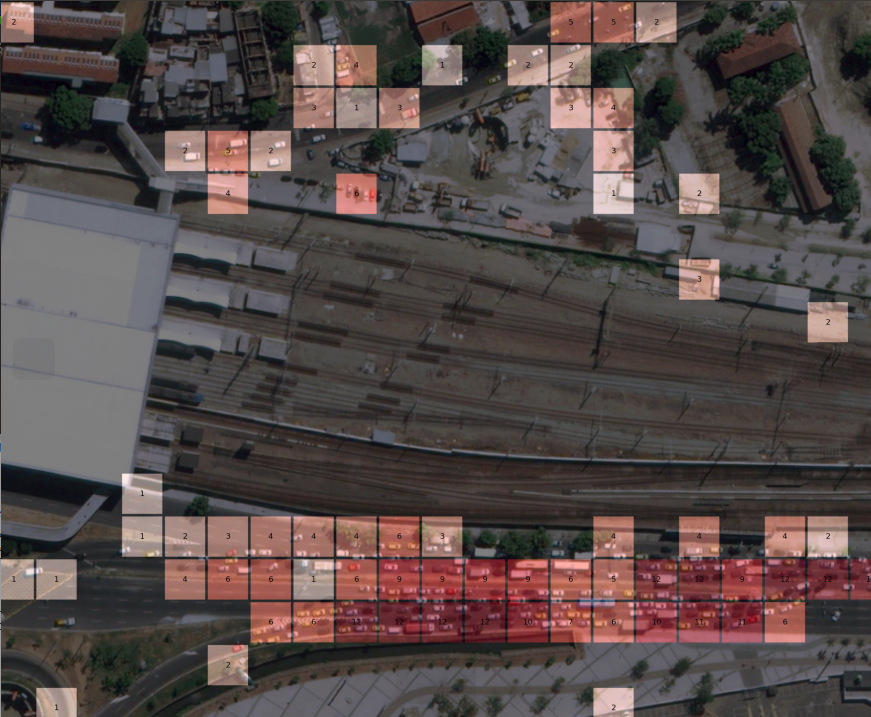

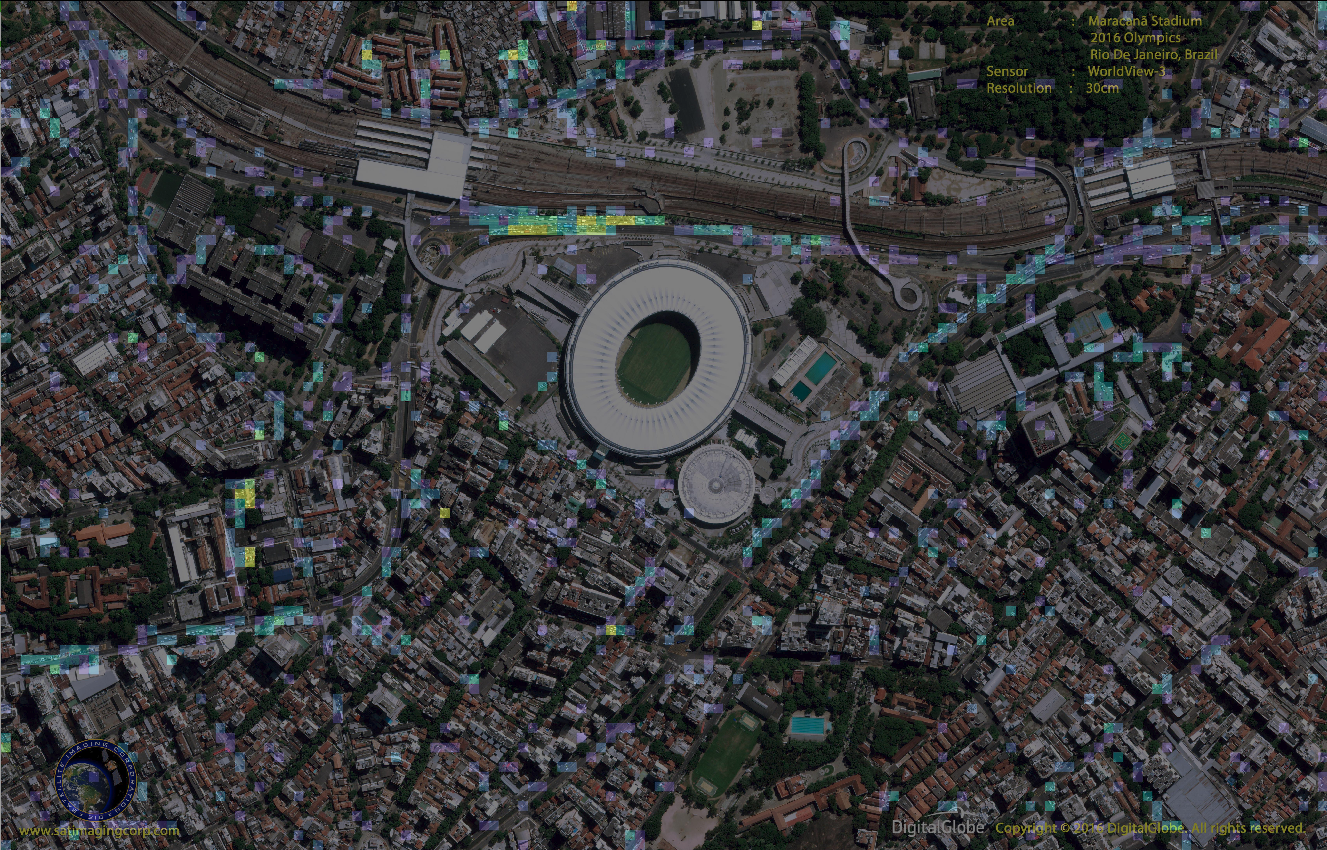

みなさん西高東低や冬型の気圧配置などという言葉を聞いたことはありませんか?日本付近の気圧配置にはいくつかのパターンがあり、西高東低とよばれる冬型の気圧配置はその中でも有名なほうでしょう(下図)。このほかにも太平洋高気圧に覆われる夏型の気圧配置などいくつかの種類があります。この記事では、このパターンを教師なし学習で分類してみようと思います。

(weather newsより)今回実行したことは以下の3つです。

- 衛星画像をスクレイピング

- エルボー法

- クラスター分析(教師無し学習)

衛星画像の取得

衛星画像の取得は江波山気象館のHPから行いました。というのも、rowデータをダウンロードするのは重く、いい感じに加工されたデータでスクレイピングしてよさそうだったのがこのサイトだったからです。

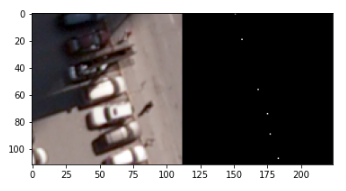

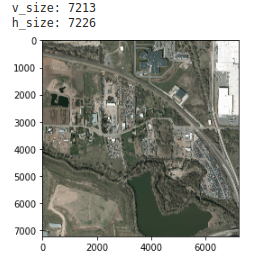

本来は 気象業務支援センターのHP から購入するのが妥当だと思われるので、ここら辺は自己判断でお願いします。ソースコードはここでは記載しませんが、 github に挙げておきます。筆者が利用した画像は日本付近の12:00(JST)の画像で、以下のような画像(854×480px)です。

前処理

import numpy as np import pandas as pd import matplotlib.pyplot as plt import seaborn as sns from PIL import Image import glob from tqdm import tqdm from os import makedirs from sklearn.cluster import KMeans from sklearn.metrics import silhouette_score, silhouette_samples x=np.empty((0,240*427)) paths=glob.glob("pictures/*.jpg") for path in tqdm(paths): img=Image.open(path) img = img.convert('L') img=img.resize((int(img.width/2), int(img.height/2))) x=np.append(x,np.array(img).reshape(1,-1),axis=0)画像を読み込んで1行になるようにreshapeしてから、numpy配列にぶち込みます。画質がいいとだいぶ時間がかかったのでグレスケにして半分の大きさにしました。

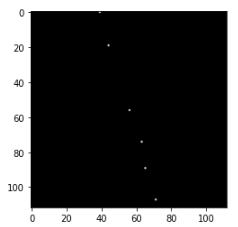

エルボー法

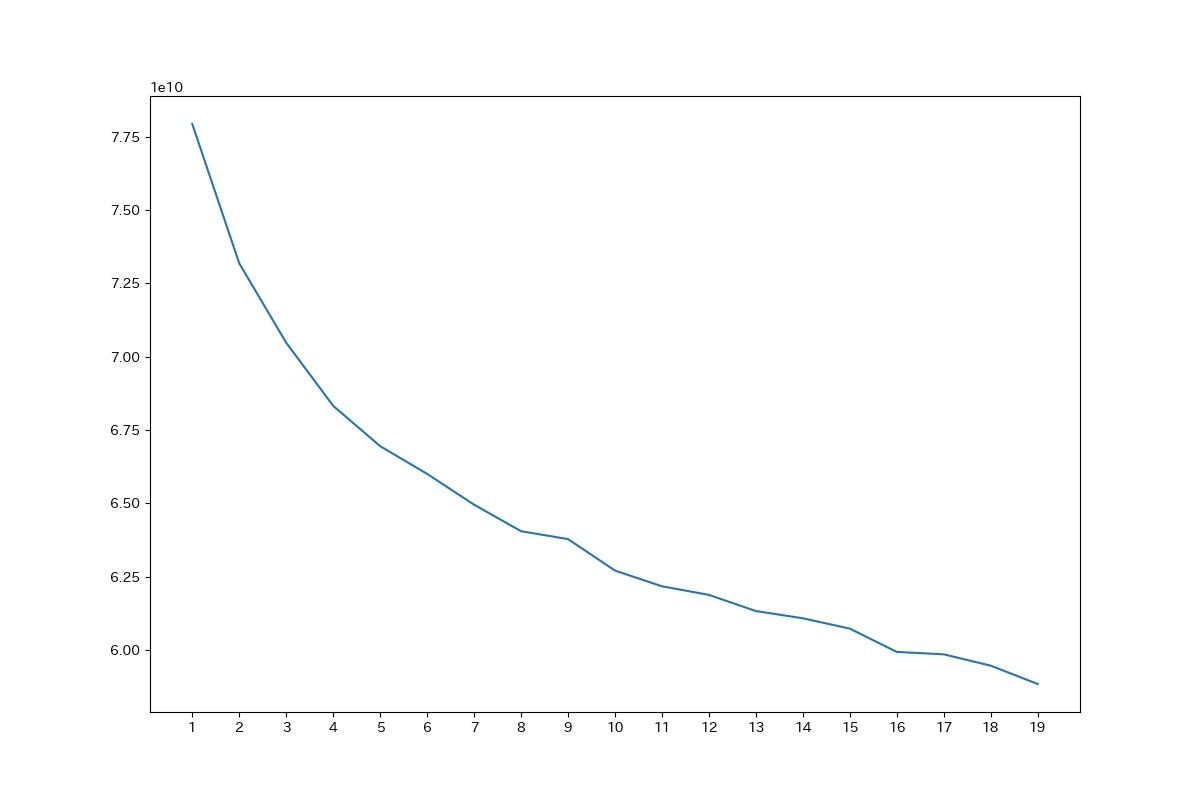

distortions = [] #エルボー法(最適なクラスター数を求める) for k in tqdm(range(1, 20)): kmeans = KMeans(n_clusters=k, n_init=10, max_iter=100) kmeans.fit(x) distortions.append(kmeans.inertia_) fig = plt.figure(figsize=(12, 8)) plt.xticks(range(1, 20)) plt.plot(range(1, 20), distortions) plt.savefig("elbow.jpg") plt.close()エルボー法により最適なクラスター数を求めました。20でやると10分ほどかかったので10ぐらいで十分かと思います。結果は以下の図のようになりました。

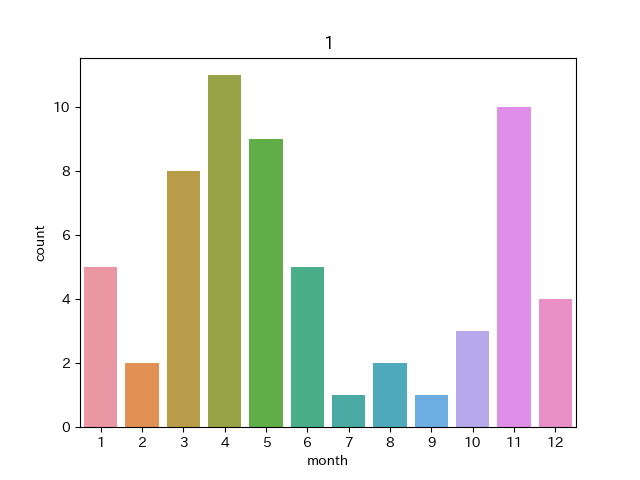

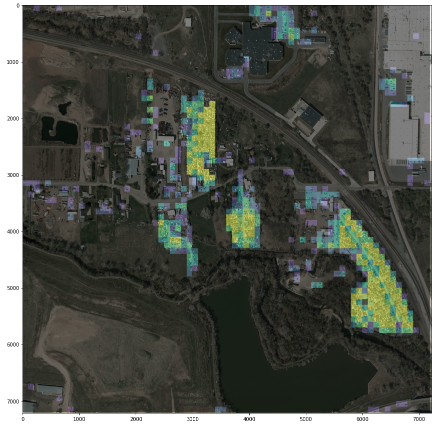

明確に何個がいいかは出ませんでしたが、今回は4でやることにしました。クラスター分析

k_means = KMeans(n_clusters=4).fit(x) y_pred = k_means.predict(x) print(k_means.labels_) print(pd.Series(k_means.labels_, name='cluster_number').value_counts(sort=False)) out=pd.DataFrame() out["picture"]=paths out["classnumber"]=y_pred out["date"]=pd.to_datetime(out["picture"].str.split("\\",expand=True).iloc[:,1].str.split(".",expand=True).iloc[:,0]) out.to_csv("out.csv")クラスターごとの要素数は139,61,68,98でした。いい感じに分かれたので期待できそうです。

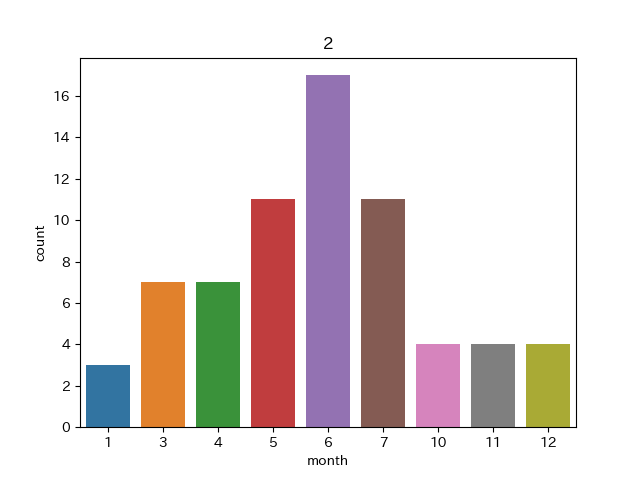

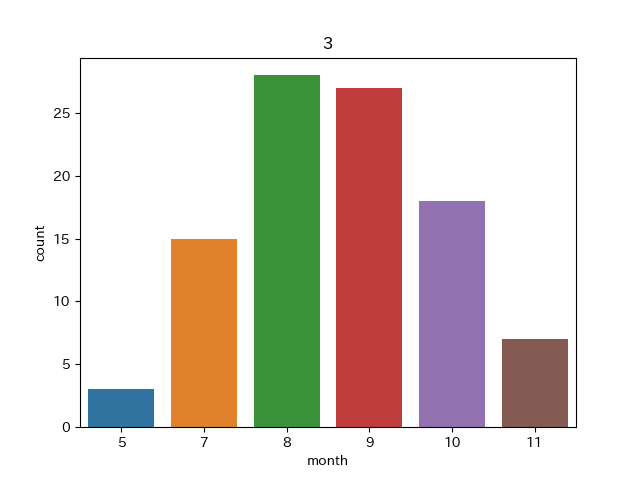

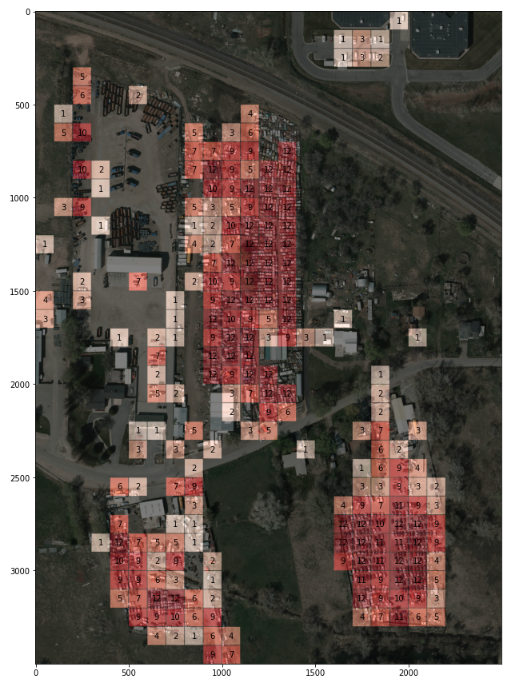

#クラスごとに保存 for i in range(4): makedirs(str(i)+"_pictures", exist_ok=True) for i in out.itertuples(): img=Image.open(i.picture) img.save(str(i.classnumber)+"_"+i.picture) for i in range(4): out["month"]=out["date"].dt.month sns.countplot("month",data=out[out["classnumber"]==i]) plt.title(i) plt.savefig("月分布"+str(i)) plt.close()それぞれのクラスごとに分けて保存するとともに、それぞれのクラスの月の分布および具体的な画像を見てみましょう。

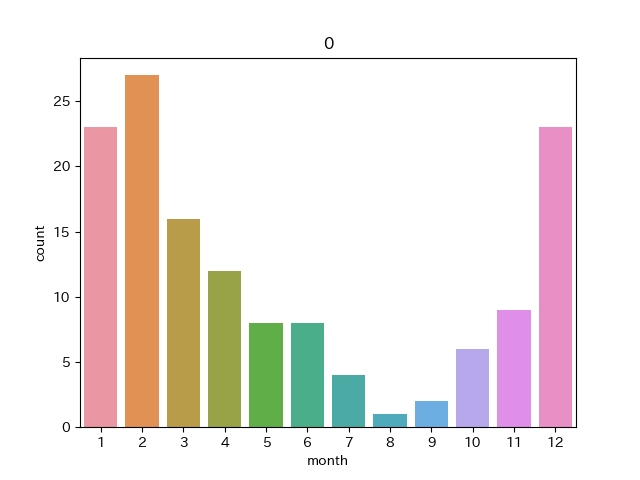

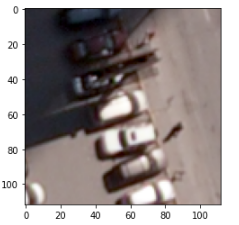

クラスターNo.0

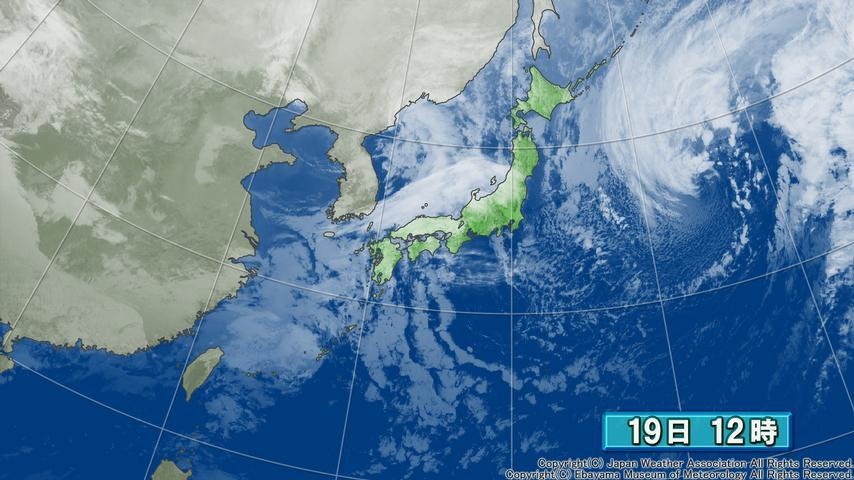

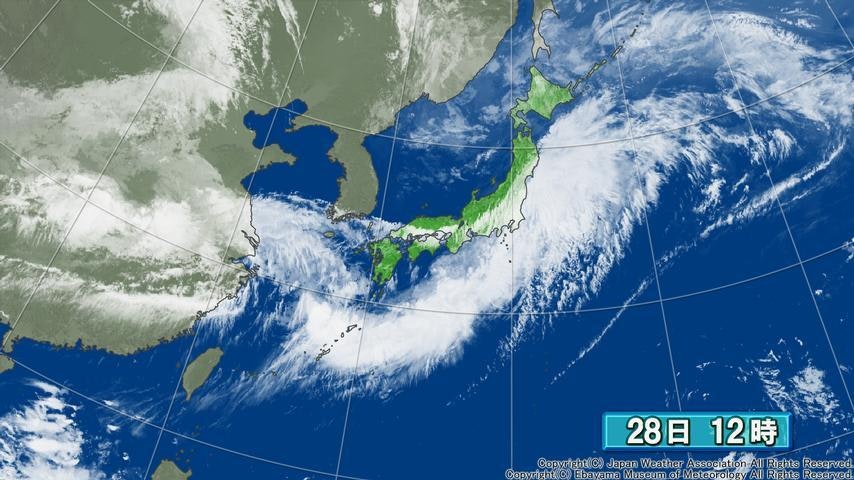

冬に多くて夏に少ない感じですね。冬型の気圧配置といったとこでしょうか。数は少ないといっても夏にもこれがみられるのは不思議な感じがします。このクラスターに属する画像は例えば以下のようなものです。

2020/1/13 2020/1/19 これは典型的な西高東低な気圧配置で北西から冷たい風が吹くことで日本列島上空に雲がかかっているような天気図でした。

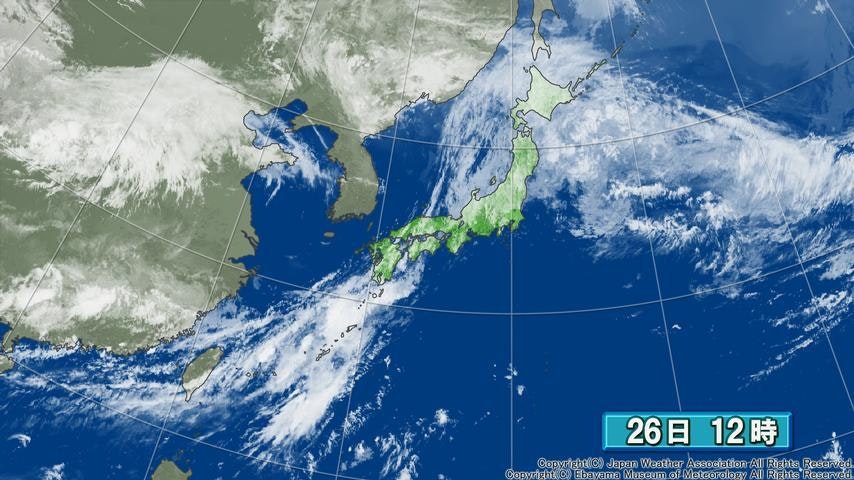

また、このクラスターに属する図で冬でない季節のものは以下の図のようなものでした。

2020/6/26 2019/10/26 雰囲気としては大陸上及び日本上空に雲があり太平洋上には雲がない感じであるということでしょうか。雲種は違えど雲の場所の雰囲気は確かに似ている気はします。

クラスターNo.1

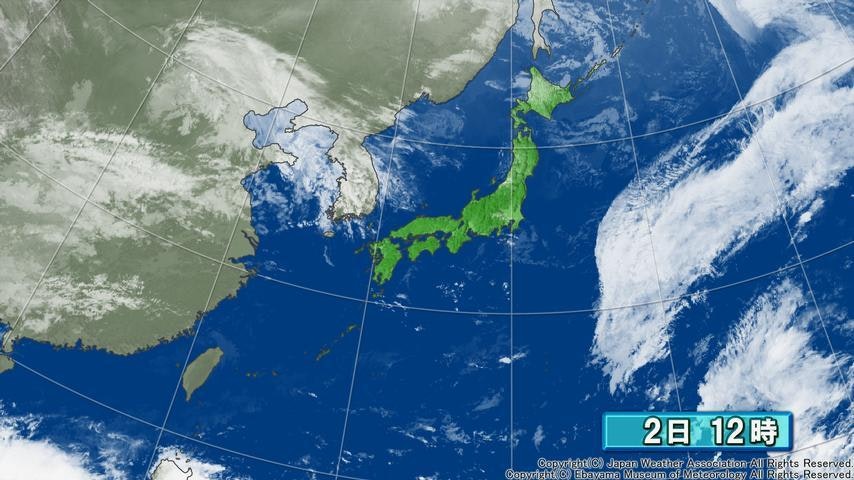

4,11月に多くなっています。このグラフだけではどのような共通点があるのかわかりませんでした。このクラスターに属する画像は例えば以下のようなものです。

2019/11/2 2020/4/29 明確な気圧配置の特徴があるわけではないように見受けられました。画像の特徴としては日本付近は晴れており、日本の南東方向に斜めの雲が入っている画像が多かったです。このような雲は季節によっては太平洋高気圧の縁を回るようにしてできているものもありましたが、偶然似通った雲ができているだけの気がします。どちらかというとこのクラスターは他のクラスターの余りのような印象が強かったです。

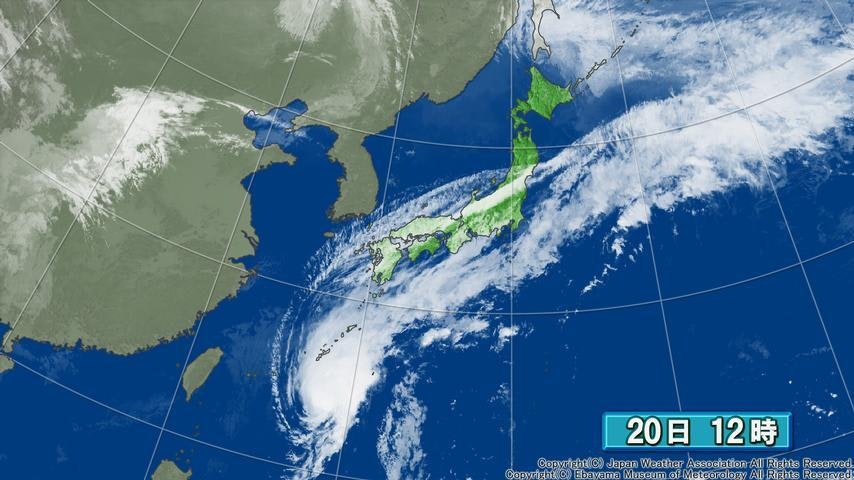

クラスターNo.2

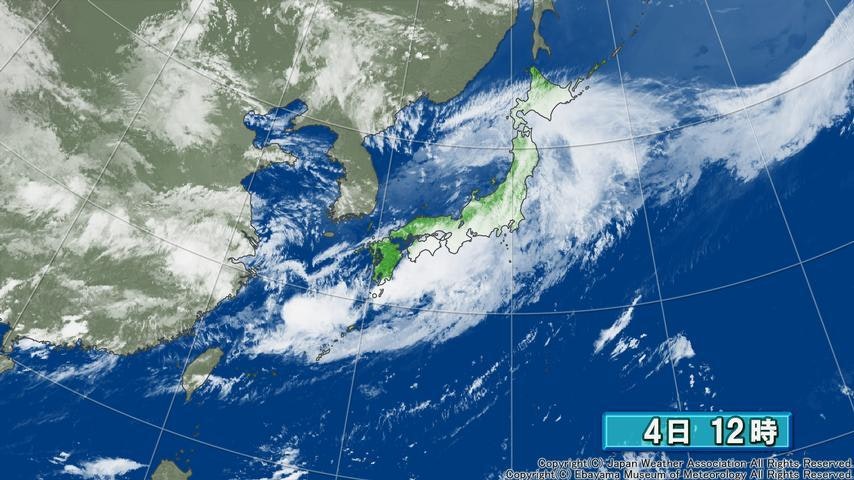

これは梅雨の時期に多い感じです。梅雨前線があるような場合の気圧配置でしょうか。なお、2,8,9月には1個も見られなかったようです。

2020/6/28 2020/7/4 このクラスターには予想通り梅雨前線を示したものが多くありました。春夏秋冬の4区分には現れない梅雨ですが、その気象学的な特徴は明確にあることが示されたのではないかと思います。

なお、このクラスターに属する他の季節の画像は以下の様なものでした。

2019/10/20 2020/3/19 日本列島上に前線によるものに近い形状の雲が広がっており、このクラスターに分類されたのが納得できます。

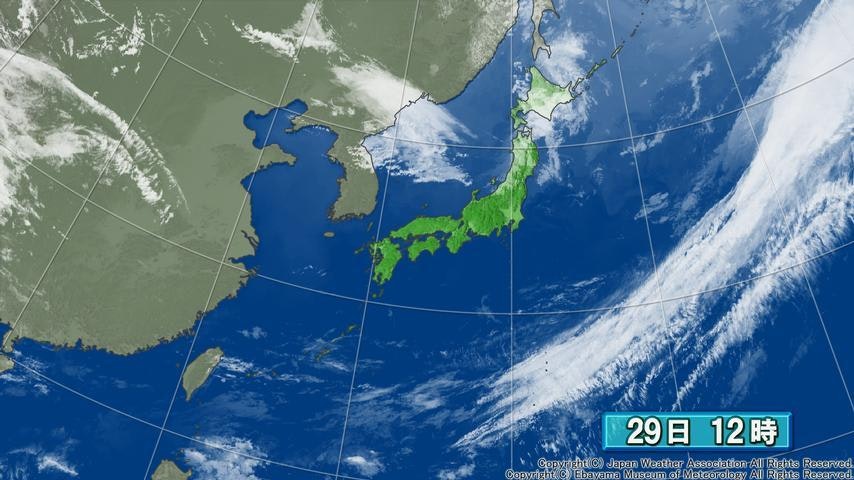

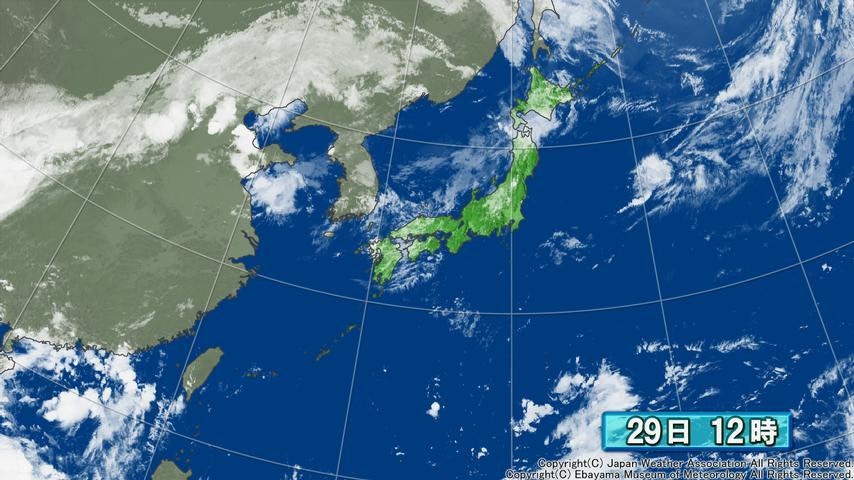

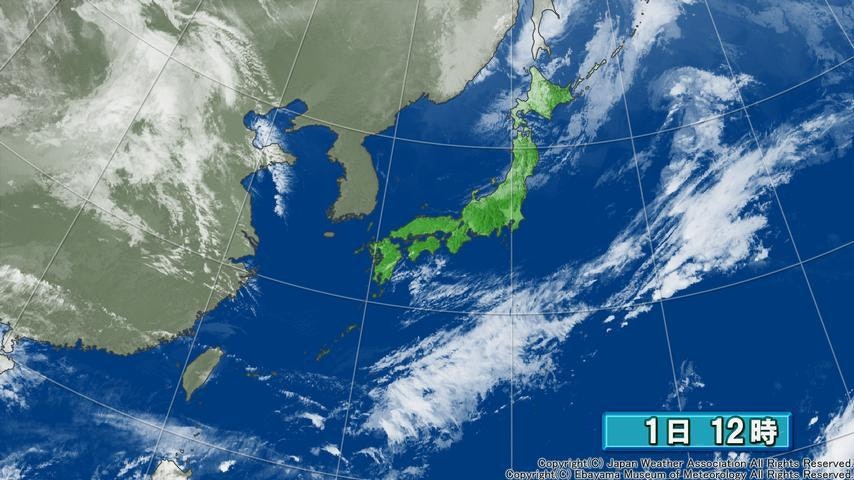

クラスターNo.3

圧倒的夏を示しています。太平洋高気圧が張りだした夏型の気圧配置を表していそうです。実際にこのクラスターに分類された画像を見てみると以下のように夏型感満載の画像でした。

2019/7/29 2019/8/21 また、他の季節の画像は晴れ間が広がった画像が多くなっていました。

2019/10/14 2019/11/1 まとめ

以上の解析結果から、クラスター分析により、大まかな気圧配置の傾向を分類し、それから外れたものも解釈することができた。ただ、衛星画像は気圧を直接表したものではないため、気圧配置を直接的に分類できるわけではなく、雲の分布状況でクラスターが分けられてしまうので、どうしても雲の形状が似ていれば誤分類されてしまう。気圧配置の分類をするためには雲だけでなく気圧を取り込む方法を検討する余地があるそうだ。

今回実行したコード(github)参考文献

- 投稿日:2020-07-28T20:05:21+09:00

Pythonビルトインの様々な文字列操作

まえおき

- この記事は執筆中のやさしくはじめるPythonプログラミングの本の特定の章の部分抜粋です。

- 入門本なので初心者の方向けです。

- ビルトインの文字列操作関係の章の内容が主になります。

- Qiita記事にマッチしていない箇所(「章」や「ページ」といった単語が使っていたり、改行数が余分だったり、リンクが対応していない等)があるという点はご留意ください。気になる方は↑のリンクの電子書籍版をご利用ください(Githubでダウンロードできます)。

- コメントなどでフィードバックいただいた場合、書籍側にも活用・反映させていただく場合があります。

文字列の各操作

前章までで基本的なPythonの操作や型・ビルトイン関数などを学んできました。本章では文字列に対して追加の操作について学んでいきます(前章までである程度操作方法について学んできましたが、他にも大切で便利な操作方法などが色々あるのでそちらを学んでいきます)。

数は多いので全ては覚えなくても、「そういえばこんなものもあった」程度で大丈夫です。必要な時に都度検索して思い出せれば問題ありません。

文字列のインデックスとスライス

リストの説明関係のセクションでスライス(リストの特定の範囲の値のみに抽出など)について学びましたが、実は文字列でも同様のスライスを行うことができます。リストの時のように、

[1:3]といったような括弧と数字・コロンを使ったインデックス範囲の指定で制御することができます。インデックスの数字は各文字ごとに割り振られます。リストの時と同じく0からスタートとなります。

例えば

Appleという文字列であれば、以下のようにインデックスが割り振られます。

- 0 → A

- 1 → p

- 2 → p

- 3 → l

- 4 → e

ある種、「文字列(string)は文字(character)を格納したリストのようなもの」とも言えるかもしれません。

実際にリスト的にインデックスへの値の参照をコードを書いて試してみましょう。

まずは特定のインデックスの内容を出力してみます(

[0]とか[1]といった指定をします)。該当する文字単体が出力されることを確認できます。str_value = 'Apple' print(str_value[0])コード実行結果の出力内容:

A

str_value = 'Apple' print(str_value[1])コード実行結果の出力内容:

p

続いて「〇〇のインデックス以降××のインデックス未満」というようにスライスで特定範囲の文字列を抽出してみます。リストと同様にコロンの左側の数字が「〇〇のインデックス以降」を表し、コロンの右側の数字が「××のインデックス未満」という条件になります。つまり

[1:4]と指定すれば、「1以降4未満」という条件(1, 2, 3のインデックスが対象)になり、Appleという文字に対して設定すればpplという部分が抽出できます。str_value = 'Apple' print(str_value[1:4])コード実行結果の出力内容:

ppl

勿論リストのスライスと同様に、コロンの左側の数字だけ指定して「〇〇以降」という条件だけ指定したり、右側の数字だけ指定して「××未満」という条件だけを指定するといった書き方もすることができます。

文字列の最初が特定の文字列になっているかどうかを調べる : startswithメソッド

文字列のstartswithメソッドでは、対象の文字列が第一引数に渡された文字列で始まっているかの真偽値を取得することができます。

「〇〇の文字列で始まる」という意味で「starts with 〇〇の文字列」といった英語で書くので、メソッド名はそちらに由来します。

プログラムでは変数名や定数名などで、同じグループの値を統一して特定の文字列から始める書き方がされることが結構あり、プレフィックス(prefix)などとも呼ばれます。

preが「前に」といった意味を持ち、「先頭に付けるもの」といったように使われます(その他にも)。例えば

ITEM_ID_というプレフィックスを使って定数にITEM_ID_〇〇といったような名前が付けられます。startswithメソッドではこのようなプレフィックスに対象の文字列がなっているかどうかを調べるのに便利です。後々の章で触れますが、プログラム内の変数名や定数名なども文字列として取得することができるので、特定のプレフィックスだったら処理を行う...といったような制御が可能になります。

使い方は第一引数にプレフィックスを指定すると、TrueかFalseかの真偽値が返却されます。

文字列が指定したプレフィックスで始まっているためTrueが返却されるケース :

str_value = 'FRUIT_ID_APPLE' print(str_value.startswith('FRUIT_ID_'))コード実行結果の出力内容:

True

文字列が指定したプレフィックスで始まっていないためFalseが返却されるケース :

str_value = 'FRUIT_ID_APPLE' print(str_value.startswith('ITEM_ID'))コード実行結果の出力内容:

False

文字列の最後が特定の文字列になっているかどうかを調べる : endswithメソッド

endswithメソッドはstartswithメソッドと似たようなメソッドとなりますが、startswithメソッドが文字列の先頭が対象なのに対してこちらは末尾が対象となります。

末尾の文字列のことはサフィックス(suffix)と言います。

startswithメソッドと同様に、endswithメソッドでも第一引数にサフィックスを指定する形で使います。結果も同様に真偽値で返ってきます。

文字列が指定したサフィックスで終わっているためTrueが返却されるケース :

str_value = 'CAT_NAME' print(str_value.endswith('_NAME'))コード実行結果の出力内容:

True

文字列が指定したサフィックスで終わっていないためFalseが返却されるケース :

str_value = 'CAT_AGE' print(str_value.endswith('_NAME'))コード実行結果の出力内容:

False

startswithとendswithメソッドはスライスでも同じようなことはできるけれども...

前のセクションで触れた通り、文字列はスライスを使って特定の範囲の文字列を抽出することができます。例えば以下のようにすると、任意の文字数のプレフィックス部分を取得することができます。

str_value = 'FRUIT_ID_APPLE' print(str_value[:6])コード実行結果の出力内容:

FRUIT_

また、後々の章で学びますが、Pythonでは

左辺の値 == 右辺の値といったように、半角のイコールの記号2つとその左右に任意の値を指定して、もし両辺の値が一致していればTrue、一致していなければFalseとなる書き方ができます。両辺の値が一致しているためTrueとなるサンプル :

int_value = 100 print(int_value == 100)コード実行結果の出力内容:

True

両辺の値が一致していないためFalseとなるサンプル :

int_value = 95 print(int_value == 100)コード実行結果の出力内容:

False

スライスとこの2つのイコールの記号を使うとstartswithメソッドやendswithメソッドででやるような判定と同じことをすることができます。例えば以下のように

[:9]とスライスで指定すれば先頭の9文字が取得できるのでその9文字を左辺、右辺に文字列で想定しているプレフィクスを指定すればstartswithメソッドを使った時と同じようにTrueもしくはFalseの真偽値を取得することができます。str_value = 'FRUIT_ID_APPLE' print(str_value[:9] == 'FRUIT_ID_')コード実行結果の出力内容:

True

ただし、この書き方は文字数を数え間違えていたり、うっかりスライスの数字の指定を間違えてしまったりすると想定した挙動になってくれません。例えば以下のようなコードは想定した判定になってくれません。

str_value = 'FRUIT_ID_APPLE' print(str_value[:9] == 'FRUIT_ID')コード実行結果の出力内容:

False

この書き方だとぱっと見で「どこが間違っているの・・・?」という点は瞬時には分かりづらいですし、コードの内容も読みづらく思えます。プレフィックス(文字の先頭)の比較はまだしもサフィックス(文字の末尾)側はもっとコードが読みづらくなります。

この辺りの間違いやすさなどはPythonのコーディング規約のPEP8でもstartswithやendswithを使うようにと定められています。

文字列に特定のプレフィックスやサフィックスがついているかをチェックするには、文字列のスライシングではなく ''.startswith() と ''.endswith() を使いましょう。

startswith() と endswith() を使うと、綺麗で間違いが起こりにくいコードになります:

Python コードのスタイルガイド他の人がコードを読んだ時に少し時間をかければしっかりと内容は把握できますが、普段の仕事で時間が限られているので極力コードは「瞬時に内容が把握できる」ものが理想です。

特に理由が無ければ、PEP8に合わせてスライスではなくstartswithなどを使って判定するようにしましょう。

文字列内に特定の文字列が含まれる位置を検索する : find, rfind, index, rindexメソッド

このセクションでは文字列のfind, rfind, index, rindexの4つのメソッドについて学びます。findメソッドは頻繁に使いますが、他の3つは比較的必要になるケースが少な目かもしれません。

findメソッドは文字列内に特定の文字列がどこに含まれているのかを調べるのに使います。

使い方は第一引数に検索したい文字列を指定します。返却値には最初に見つかった位置のインデックスが設定されます。リストなどのインデックスと同様に、インデックスの値は0から始まります(1文字目がインデックスの0、2文字目がインデックスの1というようになります)。

例えば以下のコードでは

猫という文字を検索しています。結果は3が返ってきているので、3のインデックス(4文字目)に猫という文字があるということを調べることができます。str_value = '吾輩は猫である。まだ名は無い。' print(str_value.find('猫'))コード実行結果の出力内容:

3

取得できたインデックスの整数(今回は3)を文字列に指定してみると、確かに

猫という文字と位置が一致していることが確認できます。str_value = '吾輩は猫である。まだ名は無い。' print(str_value[3])コード実行結果の出力内容:

猫

猫という文字ではなく猫であるといったような文字列を指定した場合には、その文字列がスタートするインデックスが返却されます。そのため、今回のサンプルでは猫という文字を指定した時と返っているインデックスの整数は同じ値の3となります。str_value = '吾輩は猫である。まだ名は無い。' print(str_value.find('猫である'))コード実行結果の出力内容:

3

検索に指定した文字列が見つからない場合には-1が返却されます。

str_value = '吾輩は猫である。まだ名は無い。' print(str_value.find('犬'))コード実行結果の出力内容:

-1

これを利用して、もし-1が返却されるかどうかで「特定の文字列が含まれるかどうか」の判定などにも使うことができます。

第二引数は検索するインデックス範囲の開始値です。例えば4を指定したら「4以降のインデックス範囲の文字列が検索される」挙動になります(省略した場合には先頭のインデクス0から検索が実行されます)。

以下のサンプルでは第二引数に3と4を指定しており、文字列が見つかるかどうかの結果が変わることを確認しています。

該当の文字が見つかるケースのサンプル :

str_value = '吾輩は猫である。' print(str_value.find('猫', 3))コード実行結果の出力内容:

3

開始インデックスの影響で該当の文字が見つからないケースのサンプル :

str_value = '吾輩は猫である。' print(str_value.find('猫', 4))コード実行結果の出力内容:

-1

第三引数は検索するインデックスの終了値です。省略した場合には最後の文字列まで検索が実行されます。

注意点として、ここで指定した値は「以下」の条件ではなく「未満」の条件となります。そのため3を指定した場合インデックスの3はインデックスの対象に含まれず、2までが検索対象となります。

第三引数に3を指定した結果、検索でヒットしなくなるケースのサンプル :

str_value = '吾輩は猫である。' print(str_value.find('猫', 0, 3))コード実行結果の出力内容:

-1

第三引数に4を指定した結果、範囲が4未満となるため3のインデックスの文字がヒットするケースのサンプル :

str_value = '吾輩は猫である。' print(str_value.find('猫', 0, 4))コード実行結果の出力内容:

3

findメソッドの次はrfindメソッドです。

rfindメソッドはfindメソッドとは逆に文字列の右側から検索を実施します。rは「右側から」という意味でrightのrとなっています。

例えば「吾輩は猫である。吾輩は猫ながら時々考える事がある。」という文字列に対して

猫という文字を検索した場合、右から検索して最初にヒットしたものの位置が返却値として使われるので、2番目の猫の文字の位置が対象となります。str_value = '吾輩は猫である。吾輩は猫ながら時々考える事がある。' print(str_value.rfind('猫'))コード実行結果の出力内容:

11

注意すべき点として、検索自体は右から実施されるものの、結果のインデックスの番号は左からカウントした通常のインデックスで返却されます。

以前の章のリストで触れた通り、

-1,-2,-3, ...とインデックスに指定すればそれぞれ右端の文字、右端から2番目の文字、右端から3番目の文字...といったように文字列の右端を基準としたインデックスによるアクセスもできますが、rfindメソッドでは左端の基準とした通常のインデックスの値が返却されるので通常通りにインデックスを指定すれば該当の文字を取得することができます。str_value = '吾輩は猫である。吾輩は猫ながら時々考える事がある。' index = str_value.rfind('猫') print(str_value[index])コード実行結果の出力内容:

猫

第二引数と第三引数はfindメソッドと同じく、検索するインデックス範囲の開始値と終了値(未満)となります。こちらもインデックス番号は右からではなく、通常のインデックスと同様に左からのインデックスの番号が使われます。指定したインデックスの範囲で「右側から」検索されるようになります。

str_value = '吾輩は猫である。吾輩は猫ながら時々考える事がある。' print(str_value.rfind('猫', 11))コード実行結果の出力内容:

11

str_value = '吾輩は猫である。吾輩は猫ながら時々考える事がある。' print(str_value.rfind('猫', 12))コード実行結果の出力内容:

-1

indexメソッドはほぼfindメソッドと同様の挙動をします。こちらも文字列を検索して見つかったインデックスの番号を取得する挙動となります。

ただし、findメソッドでは検索した文字列が見つからなかった時には-1が返却されていましたが、indexメソッドでは-1ではなくエラーとなります。

該当する文字列が存在するため、findと同様の挙動をするケースのサンプル :

str_value = '吾輩は猫である。' print(str_value.index('猫'))コード実行結果の出力内容:

3

該当する文字列が見つからないためエラーになるケースのサンプル :

str_value = '吾輩は猫である。' print(str_value.index('犬'))ValueError: substring not foundsubstringは特定の文字列の中の一部分の文字列という意味です。これらのメソッドでは第一引数の検索対象の文字列のことを指します。そのためエラーメッセージは「検索に指定された文字列が見つかりませんでした」といった内容になります。

最後のrindexメソッドは名前からも推測できる通り、rfindメソッドのように右から検索が実行され、且つindexメソッドのように検索に指定した文字列が見つからない場合はエラーになる挙動をします。

str_value = '吾輩は猫である。吾輩は猫ながら時々考える事がある。' print(str_value.rindex('猫'))コード実行結果の出力内容:

11

str_value = '吾輩は猫である。吾輩は猫ながら時々考える事がある。' str_value.rindex('犬')ValueError: substring not found文字列を別の文字列に置き換える : replace, translate, maketransメソッド

このセクションでは文字列の置換について学んでいきます。特定の文字列部分を別の文字列に置き換えたりといった制御が該当します。replace, translate, maketransの3つのメソッドを対象とします。特にreplaceメソッドは頻繁に利用します。

まずはreplaceメソッドについてです。replaceメソッドは特定の文字列を検索し、該当する文字列を別の文字列に置換します。

第一引数には検索する文字列、第二引数には置換後の文字列を指定します。例えば文字列の中の「猫」という部分を「犬」に置換したい場合には以下のように書きます。

str_value = '吾輩は猫である。吾輩は猫ながら時々考える事がある。' print(str_value.replace('猫', '犬'))コード実行結果の出力内容:

吾輩は犬である。吾輩は犬ながら時々考える事がある。

第三引数は置換回数の設定です。省略すると検索してヒットした文字列が全て置換されます。1を指定すると1回のみ置換、2を指定すると2回のみ置換といった挙動になります。以下のコードでは第三引数に1を指定しているため、1つ目の「猫」という文字部分のみ置換されています。

str_value = '吾輩は猫である。吾輩は猫ながら時々考える事がある。' print(str_value.replace('猫', '犬', 1))コード実行結果の出力内容:

吾輩は犬である。吾輩は猫ながら時々考える事がある。

translateとmaketransメソッドは一緒に使います。置換前の文字と置換後の文字の特定の組み合わせのものを指定して、一気に複数の文字の置換を行うことができます。

なお、対象は「1文字のもの」となります。複数の文字列のものには使えないのでreplaceメソッドの方を使いましょう。1文字同士の置換がたくさん必要な場合にはtranslateメソッドを使うことで高速に、且つシンプルなコードで置換を行うことができます。

maketransメソッドはその置換の組み合わせのデータを作るためのメソッドです。文字列のインスタンスでも使えますが、後々触れるクラスを直接指定して利用する方が一般的です(

str.maketransという書き方をします)。メソッド名はmake translation tableという英文に由来します。translationは移転や通訳という意味があり、tableは表という意味を持つので、文字と文字の変換表を作るといった感じの意味合いになります。

maketransメソッドには値の指定方法が「辞書のキーと値で指定する方法」と「第一引数と第二引数の2つのセットで指定する方法」の2つが存在します。

まずは辞書での設定の仕方を見ていきます。maketransメソッドの第一引数に辞書を指定して、キーに置換前の文字、値に置換後の文字を指定します。複数の対象がある場合には複数のキーと値のセットを指定します。

今回は以下のような組み合わせで句読点の文字を置換するコードで試してみます(左が置換前、右が置換後)。

、→,。→.trans_table = str.maketrans( { '、': ',', '。': '.', } )もしくは第一引数に置換前の文字を1文字ずつ順番に設定した文字列(今回の例では

、。という文字列)を指定し、第二引数に置換後の文字列を1文字ずつ順番に設定した文字列(今回の例では,.という文字列)を指定する方法もあります。第一引数と第二引数での文字の順番は一致するように注意してください。こちらの書き方でも辞書を使ったときと同じ挙動になります。trans_table = str.maketrans('、。', ',.')maketransメソッドで作られたデータを使ってtranslateメソッドを使ってみます。第一引数にmaketransメソッドで作られたデータを指定します。

str_value = 'ニャー、ニャーと試みにやって見たが誰も来ない。' print(str_value.translate(trans_table))コード実行結果の出力内容:

ニャー,ニャーと試みにやって見たが誰も来ない.

このセクションでは文字同士もしくは文字列同士の置換について学びました。この他にも正規表現と呼ばれるものを使って「特定のパターンにマッチするものを置換する」といった置換のやり方も存在します(且つ、便利でもあります)。

正規表現に関してはのちほど正規表現の章で詳しく触れていきます。

文字列を分割する : split, rsplit, splitlines, partition, rpartitionメソッド

このセクションでは文字列の分割について学んでいきます。split, rsplit, splitlines, partition, rpartitionの5つのメソッドが対象となります。特に一番ベーシックなsplitメソッドは多用します。

文字列の分割結果は文字列を格納したリストとなります。コンマ区切りやスペース区切り、タブ区切りなど特定の文字区切りで各値が意味を持つケースなどで利用します。

※コンマ区切りのデータはCSV(Comma Separated Valuesの略)と呼ばれ、色々な環境やツールで使われていますが、CSVの制御はこのセクションで学ぶメソッドではなく別途CSV用の機能がPythonには用意されていたり、Pandasと呼ばれるライブラリで快適に操作ができるのでそれらを使うことが多めです。CSV関係やPandasなどのライブラリは後々の章で触れます。

まずはsplitメソッドから見ていきます。splitは「分割する」といった意味を持つ単語になります。

第一引数に任意の区切り文字を指定すると、その区切り文字で分割された文字列を格納したリストが返ってきます。

以下のサンプルでは半角のコンマで文字列を分割して、1つ1つの文字列を格納したリストにしています。なお、splitメソッドでは結果のリストには分割で指定した文字列(今回のサンプルでは

,)は結果には含まれません。str_value = '100,200,300' print(str_value.split(','))コード実行結果の出力内容:

['100', '200', '300']

第二引数は分割の上限回数です。例えば2を指定したら2回分割がされ結果のリストの件数が3件になります。回数を超えた部分の文字列は分割されずにそのまま結果のリストの最後の値に残ります。

str_value = '100,200,300,400,500' print(str_value.split(',', 2))コード実行結果の出力内容:

['100', '200', '300,400,500']

第二引数を省略した場合には全ての区切り文字で分割が実施されます。

rsplitメソッドは他の先頭にrが付くメソッドと同様に、「右側から」分割処理が実行されます。ただし、第二引数を省略した場合には全ての区切り文字で分割が実行されるので、左から分割しても右から分割しても同じ結果になります。つまり、splitメソッドと同じ挙動になります。

splitと同じ結果になるrsplitのコード例 :

str_value = '100,200,300' print(str_value.rsplit(','))コード実行結果の出力内容:

['100', '200', '300']

第二引数(最大分割回数)を指定した場合には「右から」分割がされるので、リストの先頭(左端)に未分割の文字列が残ります。

str_value = '100,200,300,400,500' print(str_value.rsplit(',', 2))コード実行結果の出力内容:

['100,200,300', '400', '500']

splitlinesメソッドは文字列を改行単位で分割します。lineは行という意味も持つ単語となります。

splitメソッドで改行を指定すればいいのでは?という感じもしますが、改行の表現はOSやバージョンなどの環境で変わるうるため、全てを加味するとコードが煩雑になってしまいます。

改行は環境によって文字列中で

\nで表したり、もしくは\r\nと表されたり、\rと表されたり、もしくはクォーテーションを三つ使ってそのまま文字列内で改行を入れるということもできます。試しにWindows上のJupyterで

\nや\r\nという文字を含んだ文字列をprint関数で出力してみると、どちらも改行として表示されます。print('a\nb')コード実行結果の出力内容:

a b

print('a\r\nb')コード実行結果の出力内容:

a b

このように改行は複数の表現がありますが、ではsplitメソッドで分割しようとしたらどうなるでしょうか?たとえばsplitメソッドで改行を

\n区切りで指定していたとして、改行が\r\nで表現されているデータが来たときです。試してみると以下のように、

\r部分が結果に残ってしまって想定したものになりません。str_value = '100\r\n200\r\n300' print(str_value.split('\n'))コード実行結果の出力内容:

['100\r', '200\r', '300']

プログラムで扱う時にはその辺りの改行表現の差などを気にせずに単純に「改行で分割」としたいところです。そういったケースのために、splitlinesメソッドが用意されておりこちらを使うことで煩雑にコードを書かなくてもシンプルに改行で分割してくれます。

以下のように色々な改行を含んだ文字列に対して実行してみても、同じ結果が得られることが確認できます。

改行が

\nで表現されているケースでの分割サンプル :str_value = '100\n200\n300' print(str_value.splitlines())コード実行結果の出力内容:

['100', '200', '300']

改行が

\r\nで表現されているケースでの分割サンプル :str_value = '100\r\n200\r\n300' print(str_value.splitlines())コード実行結果の出力内容:

['100', '200', '300']

改行が

\rで表現されているケースでの分割サンプル :str_value = '100\r200\r300' print(str_value.splitlines())コード実行結果の出力内容:

['100', '200', '300']

改行が3つの連続したクォーテーションでの文字列表現で直接記述されているケースでの分割サンプル :

str_value = """100 200 300 """ print(str_value.splitlines())コード実行結果の出力内容:

['100', '200', '300']

partitionメソッドはsplitメソッドと同じように、区切り文字を指定して分割を実行します。ただし以下の点がsplitメソッドと異なります。

- 分割は1回のみ実施されます。

- 分割後の左側の文字列、区切り文字、分割後の右側の文字列の3つの値を格納したタプルが返却されます。

- splitメソッドはリストが返却され、partitionメソッドは分割結果の値が3件になるのを加味してかタプルとなります。返却値の型が異なるので注意してください。

- splitメソッドでは区切り文字は結果のリストには含まれませんが、partitionメソッドでは区切り文字も結果のタプルに含まれます。

実際にコードを書いて試してみます。サンプルとしてコロンを含んだ文字列に対して試してみると、コロンの左右の文字列で結果が分割されていることが確認できます。

str_value = '100:200' print(str_value.partition(':'))コード実行結果の出力内容:

('100', ':', '200')

文字列中に複数の区切り文字が含まれていても分割は1回しかされません。タプルの右側の値に区切り文字がそのまま残ります。

str_value = '100:200:300:400' print(str_value.partition(':'))コード実行結果の出力内容:

('100', ':', '200:300:400')

文字列中に引数で指定した区切り文字が無い場合には、タプルの最初のインデックスに元の文字列が配置され、2つ目と3つ目のインデックスには空文字が設定されます。区切り文字も含まれない形となります。タプルの値の件数は3件のままです。

str_value = '100:200' print(str_value.partition(','))コード実行結果の出力内容:

('100:200', '', '')

最後のrpartitionメソッドはメソッド名からも推測できるように、「右から」分割がされます。他の挙動はpartitionと同じです。

str_value = '100:200:300:400:500' print(str_value.rpartition(':'))コード実行結果の出力内容:

('100:200:300:400', ':', '500')

文字列内に変数などを差し込んだり、特定のフォーマットで値を挿入する : %記号, format, format_mapメソッド, f-strings

変数の値を差し込んだ文字列を作る場合、文字列同士を

+の記号で連結する方法があります。例えば以下のような書き方をします。name = 'タマ' concatenated_str = '飼っている猫の名前は' + name + 'です。' print(concatenated_str)コード実行結果の出力内容:

飼っている猫の名前はタマです。

しかし、もし変数の値が文字列以外の値、例えば整数などの場合にはこの方法だとそのままだとエラーになってしまいます。例えば以下のように

ageという整数の変数を連結しようとするとエラーになります。age = 5 concatenated_str = '飼っている猫の歳は' + age + '歳です。'TypeError: can only concatenate str (not "int") to strconcatenateは「連結する」といった意味の単語なので、エラーメッセージは「文字列と(整数ではなく)文字列のみが連結できるよ」といったような内容になります。

整数もしくは別の文字列以外の型の変数を文字列の連結に使いたい場合にはキャストと呼ばれる処理を挟んで対象の変数を文字列にする必要があります(キャストについては後々の章で触れます)。

文字列へのキャストするには対象の変数などを

str()関数の引数に渡すことで実現できます。先ほどのエラーが出てしまったコードをエラーが出ないように文字列にキャストするように書き直すと以下のようになります。age = 5 concatenated_str = '飼っている猫の歳は' + str(age) + '歳です。' print(concatenated_str)コード実行結果の出力内容:

飼っている猫の歳は5歳です。

この書き方でもやろうとしていた「文字列に変数を差し込んで連結する」という目的は達成できました。ただ、少し記述が煩雑(

+の記号やキャスト部分など)ですし、文字列の変数想定だった箇所が何かの拍子に別の型の値になってしまって、キャストを忘れていてエラーになってまう・・・みたいなケースも無いわけではありません。前置きが長くなりましたが、このセクションではそういったケースによりシンプルに・より読みやすい形に文字列へ変数を差し込む方法を学んでいきます。

まずは

%記号を使った書き方から学んでいきます。前の章で触れたように、%の記号は整数で使うと余り(剰余)の計算をすることができます。6 % 4コード実行結果の出力内容:

2

一方文字列では

%の記号を使って文字列中に変数を差し込む挙動に使われます。%記号と一緒に特定のフォーマットを表す英文字を文字列中で指定して使います。まず最初は「文字列(string)そのままのフォーマット」としてのsを付与した形の%sという表記で文字列でサンプルコードを書いていきます。文字列と差し込みたい変数の間にはさらに

%記号で間を分割し、左に文字列右に変数という形で以下のように書きます。age = 5 concatenated_str = '飼っている猫の歳は%s歳です。' % age print(concatenated_str)コード実行結果の出力内容:

飼っている猫の歳は5歳です。

変数を差し込む部分が

%sのみとなり、複数の+記号などが消えてすっきりとした記述となりました。また、対象の変数の文字列へのキャスト(str())も省略する形で書けています。

%sの他には%dや%.3f、%xといったような色々な指定があります。ビルトイン関数の章のformat関数でも色々触れましたが、それぞれ以下のような意味と挙動になります(ここで触れる以外にも色々とあります。format関数のセクションで色々説明をしたので、ここでは10進数や16進数などの説明は割愛します)。

%s-> string。文字列としてそのまま扱われます(str()関数でキャストした場合と同じような挙動)。文字列への変数の値の挿入などでは一番使う機会が多くなると思います。%d-> digit。普段の生活で使っている0~9の範囲での10進数での値で文字列内に挿入されます。%.3f-> float。浮動小数点数で文字列内に挿入されます。3といった部分は任意の数字で、小数点以下第何位まで表示するのかの指定となります。3と指定すれば0.000といったような数値で文字列に反映されます。%x-> hex。16進数で文字列内に挿入されます。一部、

%s以外も実際にコードを書いて挙動を確かめてみます。まずは%dです。%dでは10進数の整数として文字列に値が挿入されます。5.5といった小数を含んだ値を指定しても整数に変換されるので5といった値で文字列で出力されます。age = 5.5 concatenated_str = '飼っている猫の歳は%d歳です。' % age print(concatenated_str)コード実行結果の出力内容:

飼っている猫の歳は5歳です。

%dを使った場合には、指定する変数などの値は「整数に変換できる数値」である必要があります。浮動小数点数や整数などは指定できますが、それ以外の例えば文字列などを指定するとエラーになってしまいます(文字列などを挿入する必要があれば%sなどの方を使います)。name = 'タマ' concatenated_str = '飼っている猫の名前は%dです。' % nameTypeError: %d format: a number is required, not strエラーメッセージは「

%dのフォーマットでは文字列ではなく数値が必要だよ」といったようなメッセージになっています。

%.3fを使うと、指定する変数の値が小数点以下の特定の桁数の文字列で挿入されます。5.5という値の変数で%.3fとフォーマットを指定すれば5.500という値で文字列に挿入されます。%.2fとすれば小数点以下第二位まで表示され、5.50といった値で挿入されます。age = 5.5 concatenated_str = '飼っている猫の歳は%.3f歳です。' % age print(concatenated_str)コード実行結果の出力内容:

飼っている猫の歳は5.500歳です。

文字列中に複数の変数を挿入したい場合には、タプルの括弧を使って複数の変数を指定します。例えば

(name, age)といったようにタプルで書きます。name = 'タマ' age = 5 concatenated_str = \ '飼っている猫の名前は%sです。歳は%s歳です。' % (name, age) print(concatenated_str)コード実行結果の出力内容:

飼っている猫の名前はタマです。歳は5歳です。

文字列中の

%sなどの指定と、タプル内の値の件数は一致していないとエラーになります(関数の引数で数が合っていない時にエラーになるのと似たような形ですね)。以下のコードでは文字列中に

%sの指定が3つある一方で、タプル側の変数が2つしかないためエラーになっています。name = 'タマ' age = 5 concatenated_str = \ '飼っている%sの名前は%sです。歳は%s歳です。' % (name, age)TypeError: not enough arguments for format stringエラーメッセージは「文字列の整形(ここでは変数の挿入)に必要な引数(各変数)が足りていないよ」といったメッセージになります。

タプル側の件数が多くてもエラーになります。

name = 'タマ' age = 5 concatenated_str = \ '飼っている猫の名前は%sです。歳は3歳です。' % (name, age)TypeError: not all arguments converted during string formatting「文字列の整形(変数の挿入)中に、全ての引数(タプル内の各変数)が(

%sの数が足りなくて)変換(挿入)できませんでした」といったようなエラーメッセージの内容になります。また、複数の値の挿入処理にはタプルが使われるため、タプル自体を挿入したい場合にはそのままだとうまくいきません。

%sなどの表記が1つだけで且つ複数の値を格納したタプルの変数を指定した場合には前述の通り件数が一致していないと判断されてエラーになってしまいます。このようなケースではタプルの文字列へのキャストなどの制御が必要になってしまいます。それ以外にも、関数で引数の数が増えると読みづらくなってくるといったのと同様に、文字列中に

%sの記述が多くなってくると順番などの制御などでミスをしやすくなってきます。キーワード引数のような機能が欲しくなってきます。その辺りの

%による制御の問題点を改善する形で、後述のformatメソッドが%による制御よりも後のPythonバージョンで追加されています。

%記号による制御の次はformatメソッドについて学んでいきます。%記号を使った変数などの値の文字列への挿入処理と同様に使えますが、こちらの方がPythonのバージョン的に新しい機能であり、コードの記述量は少し増えますが色々と機能が増えていたり問題点などが改善されていたりします。使い方としては、まずは文字列中に

{}の括弧を変数の値を入れたいところに追加します。その後にその文字列でformatメソッドを実行し、引数として挿入したい変数を指定します。シンプルな例だと以下のようなものになります。name = 'タマ' formatted_str = '飼っている猫の名前は{}です。' formatted_str = formatted_str.format(name) print(formatted_str)コード実行結果の出力内容:

飼っている猫の名前はタマです。

複数の変数を挿入したい場合には

{}の括弧を複数文字列内に設定します。name = 'タマ' age = 5 formatted_str = '飼っている猫の名前は{}です。歳は{}歳です。' formatted_str = formatted_str.format(name, age) print(formatted_str)コード実行結果の出力内容:

飼っている猫の名前はタマです。歳は5歳です。

複数の引数を指定した際には順番に

{}部分に値が設定されていきます。例えば(name, age)と引数に指定した場合には文字列中の最初の{}部分にnameの引数の値が設定され、次の{}部分にageの引数の値が反映されます。この順番を調整したい場合には

{}の括弧の中に整数の値を設定して{0}や{1}といったような書き方をします。括弧内の整数は0から始まる引数の番号です(最初の引数が0、その次が1、その次が2...となります)。以下のように実際にコードを書いてみると、第三引数(

name)の方が文字列中で第二引数(age)の値よりも先に文字列内で設定されることを確認できます。animal = '猫' name = 'タマ' age = 5 formatted_str = '飼っている{0}の名前は{2}です。歳は{1}歳です。' formatted_str = formatted_str.format(animal, age, name) print(formatted_str)コード実行結果の出力内容:

飼っている猫の名前はタマです。歳は5歳です。

{}の括弧で一部はそのままの文字列として使うケースで、且つformatメソッドでの変数の差し込みなどもやりたい場合には{{}}と括弧を二重に記述するとその括弧はformatメソッドで無視される普通の括弧の文字列({})として扱われます(こういった制御をエスケープするなどと言われます)。以下のサンプルではformatメソッドを使ってもエスケープされた

{}の括弧の部分が出力に残っていることが確認できます。name = 'タマ' age = 5 formatted_str = '飼っている{{猫}}の名前は{}です。歳は{}歳です。' formatted_str = formatted_str.format(name, age) print(formatted_str)コード実行結果の出力内容:

飼っている{猫}の名前はタマです。歳は5歳です。

また、

{name}や{age}といったように括弧の中に引数名を書いておくことで、キーワード引数のように変数の差し込みを指定することもできます。引数の順番のミスなどを避けれますし、引数が多くなっても読みやすいコードにすることができます。cat_name = 'タマ' cat_age = 5 formatted_str = '飼っている猫の名前は{name}です。歳は{age}歳です。' formatted_str = formatted_str.format( name=cat_name, age=cat_age, ) print(formatted_str)コード実行結果の出力内容:

飼っている猫の名前はタマです。歳は5歳です。

このキーワード引数を使う書き方は仕事でも高い頻度で利用しています。シンプルな変数値の挿入であれば

%記号を使った処理を使うことも多いですが、変数の数が多くなった場合(3つ以上など)には可読性などの面からformatメソッドでキーワード引数を使って記述することが多めです。引数の数が多くなると読みづらくミスしやすくなってくるので、積極的にキーワード引数などを使っていきましょう。以下は少し発展的な書き方且つ使う機会は低めとなりますが、

{}の括弧で指定された値がリストや辞書などの場合、インデックス的に参照することができます。たとえば

{0}と書くと第一引数の変数が参照されますが、もしその第一引数の値がnameというキーを持つ辞書であれば{0[name]}と書くことで文字列中に辞書のnameキーの値を展開することができます。このサンプルでは第一引数({0})を使っていきますが、第二引数以降でも勿論使用することができます。dict_value = { 'name': 'タマ', 'age': 5, } formatted_str = \ '飼っている猫の名前は{0[name]}です。歳は{0[age]}歳です。' formatted_str = formatted_str.format(dict_value) print(formatted_str)コード実行結果の出力内容:

飼っている猫の名前はタマです。歳は5歳です。

リストでも同様なことはできます。例えば第一引数にリストの変数を指定して

{0[0]}と書けば第一引数のインデックス0の値、{0[1]}と書けば第一引数のインデックス1の値が展開されます。list_value = [ 'タマ', 5, ] formatted_str = '飼っている猫の名前は{0[0]}です。歳は{0[1]}歳です。' formatted_str = formatted_str.format(list_value) print(formatted_str)コード実行結果の出力内容:

飼っている猫の名前はタマです。歳は5歳です。

こういった書き方は、多用すると括弧やインデックスの数値などが連続するのでコードが読みづらくなるケースが起こりえます。リストや辞書などを使う場合にも、文字列中はキーワード引数の値単体で設定(例えば

{name}といった形など)して、引数指定時にインデックスなどを参照することで同じことはできるため、コードが読みづらくなってきたらキーワード引数単体での書き方などがおすすめです。以下書き換え例です。list_value = [ 'タマ', 5, ] formatted_str = '飼っている猫の名前は{name}です。歳は{age}歳です。' formatted_str = formatted_str.format( name=list_value[0], age=list_value[1], ) print(formatted_str)コード実行結果の出力内容:

飼っている猫の名前はタマです。歳は5歳です。

第一引数としての

{0}という表記をサンプルで使ってきましたが、他の書き方、例えばキーワード引数を使ったような書き方も勿論できます。例えば{name_dict[cat_name]}みたいな書き方ができます(サンプルでは文字列が長くなってきたので()の括弧と改行を使っています)。name_dict = {'cat_name': 'タマ'} age_list = [5] formatted_str = ( '飼っている猫の名前は{name_dict[cat_name]}です。' '歳は{age_list[0]}歳です。' ).format( name_dict=name_dict, age_list=age_list, ) print(formatted_str)コード実行結果の出力内容:

飼っている猫の名前はタマです。歳は5歳です。

文字列内で辞書に対して特定のキーの値に対してアクセスする方法に関して、注意点としてキーに変数などは使えません。

通常の辞書の値への参照ではキーに変数などが使えます。例えば以下のような辞書の値へのアクセス(

[name_key]といった書き方)ができます。dict_value = {'cat_name': 'タマ'} name_key = 'cat_name' print(dict_value[name_key])コード実行結果の出力内容:

タマ

一方で文字列内での辞書の値のキーの参照は

{dict_value['name']}という書き方ではなく、直接[name]といったようにクォーテーション('記号など)無しで記述します。その際にはnameという変数ではなくnameというキー名でのアクセスとなります。特定のキーに対して変数を使って文字列に値を挿入したい場合には、文字列内でキーへ変数は使えないので、以下のように文字列の外で引数で指定する箇所で(name=dict_value[name_key]といった書き方で)設定する必要があります。name_key = 'name' age_key = 'age' dict_value = { name_key: 'タマ', age_key: 5, } formatted_str = '飼っている猫の名前は{name}です。歳は{age}歳です。' formatted_str = formatted_str.format( name=dict_value[name_key], age=dict_value[age_key], ) print(formatted_str)コード実行結果の出力内容:

飼っている猫の名前はタマです。歳は5歳です。

続いて

{}の括弧内でコロンを使った書き方について学びます。括弧内で半角のコロンを設定し、コロンの左側に対象の変数(引数順に応じた{0}や{1}もしくはキーワード引数による{name}といったような書き方の部分)を記述し、コロンの右側にフォーマットの文字列(.3fなど)を指定することで、特定のフォーマットで値を挿入することができます。{0:.3f}や{name:.3f}といったようにコロンを使って書きます。

%記号を使った書き方の際の%dとか%.3fとかの%を除いた部分が該当し、機能もそれらと同じように動作します(例えば.3fと指定すれば小数点以下第三位までの文字列の形式で表示されるといった挙動は同じです)。以下のサンプルでは

ageというキーワード引数を挿入し、小数点以下第三位まで表示する指定で{age:.3f}という指定を文字列中でしています。出力結果の文字列が元の値の5.5ではなく第三位まで表示する形で5.500となっている点が確認できます。age = 5.5 formatted_str = '猫の年齢は{0:.3f}歳です。' formatted_str = formatted_str.format( age, ) print(formatted_str)コード実行結果の出力内容:

猫の年齢は5.500歳です。

このセクションの最後のメソッドはformat_mapです。

format_mapメソッドはformatメソッドとほぼ同じような挙動をします。ただし、引数には辞書を1つ指定する形になっています。引数の辞書の各キーと値のセットが、formatメソッドでキーワード引数を使った時のように展開されて文字列中に各値が展開されます。

dict_value = { 'name': 'タマ', 'age': 5, } formatted_str = '飼っている猫の名前は{name}です。歳は{age}歳です。' formatted_str = formatted_str.format_map(dict_value) print(formatted_str)コード実行結果の出力内容:

飼っている猫の名前はタマです。歳は5歳です。

関数の章でも触れましたが関数(もしくはメソッド)実行時の引数に半角のアスタリスク2個と辞書をセットで引数に指定すると辞書内のキーと値をキーワード引数として展開してくれることを学びました。そちらの書き方とformat関数を組み合わせると、実はformat_mapメソッドを使わなくても同じような挙動を実現できます。例えば以下のようにformatメソッドの引数に

**dict_valueと指定すればformat_mapメソッドを使った時と同じ結果を得ることができます。dict_value = { 'name': 'タマ', 'age': 5, } formatted_str = '飼っている猫の名前は{name}です。歳は{age}歳です。' formatted_str = formatted_str.format(**dict_value) print(formatted_str)コード実行結果の出力内容:

飼っている猫の名前はタマです。歳は5歳です。

formatメソッドでもformat_mapメソッドと同じ結果を得られるのに何故format_mapメソッドが用意されているのでしょう?理由としては以下のようなものがあります。ただし、細かい制御とかが必要になった時にformat_mapが必要になる時が稀にある・・・といった程度で、利用頻度的にはformat_mapメソッドは大分少なくなります。

- format_mapメソッドでは引数の辞書のコピーは作成されません。2個のアスタリスクと辞書をformatメソッドに指定した場合は引数に指定した辞書のコピーが作成されます。コピーされる分、メモリや処理時間が僅かに増加します。そのため大きいデータの辞書などを指定する際にはformat_mapの方がパフォーマンス的に有利になります。ただし、大抵はキーワード引数で指定するようなケースでは小さい辞書のケース(数値や文字列が数点など)が多いと思いますので、ほとんどのケースでは差は誤差の範囲です。

- 後々の章で触れますが、クラスを使った継承などの機能を使って辞書の一部の機能を書き換える(上書きする)といったコードを書くことがあります。そのような場合にアスタリスクを2個使った引数指定では「辞書としてコピーされる」ために上書きした部分が無視されてしまうといったケースが発生します。この辺りは後々の章で触れますので、今は「カスタマイズしたものがformatメソッドでは無視されてしまうケースが稀に発生する」程度にお考えください。

このセクションの最後に、f-strings(f文字列)にも触れていきます。

f-stringsとは、文字列の引用符(シングルクォーテーションなど)の前にfという文字を付与することで、文字列中に変数などを差し込んだりPythonのコードを実行することができる機能です。

変数部分やPythonのコード部分にはformatメソッドと同じように

{}の括弧で囲みます。シンプルなサンプルコードとしては以下のようになります。

猫の...という文字列部分の先頭にfという文字が付与されていることと、formatなどのメソッド無しにnameという変数が結果の文字列に含まれているという点に注目してください。name = 'タマ' txt = f'猫の名前は{name}です。' print(txt)コード実行結果の出力内容:

猫の名前はタマです。

f-stringsを使うと直接変数の挿入などが対応でき、formatメソッドなどの呼び出しも不要なのでコード量が短くて済むというメリットがあります。できることとしては書き方は結構異なるものの、formatメソッドに近い内容となっています。

f-stringsでの

{}の括弧内ではPythonでの処理などを書くこともできます。例えば以下のように文字列内で足し算をしたりすることもできます。age = 5 print(f'来年は{age + 1}歳になります。')コード実行結果の出力内容:

来年は6歳になります。

関数の実行なども文字列中で行うことができます。

def get_name(): return 'タマ' print(f'猫の名前は{get_name()}です。')コード実行結果の出力内容:

猫の名前はタマです。

%記号を使った書き方やformatメソッドで、フォーマット(例えば小数点以下第何位までの文字列にするのかなど)を指定するにはformatメソッドと同じように半角のコロンの記号(:)を挟み、右側にフォーマットを指定します。value = 123.456789 print(f'小数点以下第三位までを含んだ値は{value:.3f}です。')コード実行結果の出力内容:

小数点以下第三位までを含んだ値は123.457です。

なお、このフォーマット指定部分(コード上では

.3fとなっている部分)は書式指定子(format specifier)などと呼ばれます。Python内部のコードを読むと、引数名などがformat_specなどになっていますがこの引数名はformat specifierに由来します。f-strings中では、このフォーマット指定子部分でさらに

{}の括弧を入れる(入れ子にすると言います)と、フォーマット指定子部分にも変数を指定することができます(条件に応じてフォーマット指定子を変更したりすることができます)。format_spec = '.2f' value = 123.456789 print(f'小数点以下第二位までを含んだ値は{value:{format_spec}}です。')コード実行結果の出力内容:

小数点以下第二位までを含んだ値は123.46です。

任意の文字列でリストの値を1つの文字列に連結する : joinメソッド

joinメソッドは任意の文字列を格納したリストなどの値を、指定の文字列を間に挟んだ形で連結をします。

間に挟む文字列は変数も使えますが、直接固定の文字や文字列が指定されることが多めです。例えばコンマ区切りでリストの値を連結したい時には

','.joinといった形の書き方がされます。メソッドの第一引数に連結したいリスト(もしくはタプルなどの値)を指定します。コンマ区切りでリスト(

animalsという変数)を連結するサンプル :animals = ['猫', '犬', '兎'] print(','.join(animals))コード実行結果の出力内容:

猫,犬,兎

アンダースコア二個(

__)でリストを連結するサンプル :animals = ['猫', '犬', '兎'] print('__'.join(animals))コード実行結果の出力内容:

猫__犬__兎

リストの中身が文字列以外(数値など)になっている場合にはエラーになります。

int_list = [1, 2, 3] print(','.join(int_list))TypeError: sequence item 0: expected str instance, int foundリストやタプルのような順番を持った各値を格納したものは総括してシークエンス(sequence)とも呼ばれます。

そのためエラーメッセージは「シークエンス(リスト)のインデックス0の要素(item)で、文字列(str)のインスタンス想定のところに整数(int)の値がありました」といったよう内容になります。文字列中に出現する特定の文字列の回数を取得する : countメソッド

countメソッドは第一引数に指定した文字列が、対象の文字列中にいくつ含まれているかの件数を返します。

文字列中に「猫」という文字が4つあるため4が返却されているサンプル :

txt = ( '吾輩は猫である。' 'その後猫にもだいぶ逢ったがこんな片輪には一度も出会わした事がない。' '猫が来た猫が来たといって夜中でも何でも大きな声で泣き出すのである。' ) print(txt.count('猫'))コード実行結果の出力内容:

4

第二引数は検索範囲の開始インデックス、第三引数は検索範囲の終了インデックスから1マイナスした値となります。

0~11までのインデックスの文字列範囲を検索対象とするサンプル :

txt = ( '吾輩は猫である。' 'その後猫にもだいぶ逢ったがこんな片輪には一度も出会わした事がない。' '猫が来た猫が来たといって夜中でも何でも大きな声で泣き出すのである。' ) print(txt.count('猫', 0, 12))コード実行結果の出力内容:

2

それぞれスライスで使われるコロンの右側の整数と右側の整数の値に該当します。つまり、検索対象の範囲を確認するには以下のような文字列へのスライスをすることで対応ができます(前述のコードサンプルの第二引数の0と第三引数の12をスライスで指定しています)。

print(txt[0:12])コード実行結果の出力内容:

吾輩は猫である。その後猫

文字列の端から空白文字などの特定の文字を取り除く : strip, lstrip, rstripメソッド

stripメソッドでは文字列の先頭と末尾の特定の文字を削除します。stripは「取り除く」といった意味の単語になります。

replaceメソッドで空文字を指定(空文字で置換)しても、特定の文字列を削除することができますが、replaceメソッドと比べてstripメソッドは以下の違いがあります。

- 引数は省略することができます。

- 引数を省略した場合は、文字列両端のスペースや改行などの空白文字と呼ばれる文字が削除されます。

- 文字列ではなく文字単位で削除が実行されます。例えば引数に

猫犬という文字列を指定した場合、猫犬という文字列で削除がされるのではなく、猫と犬という文字単位で削除がされます。まずは引数を省略したケースでの挙動を確認してみます。以下のような文字列の両端にスペースや改行などの空白文字(

\nは改行1つ分を表す文字になります)を含んだ文字列で進めます。txt = ' 吾輩は猫である。\n\n' print(txt)コード実行結果の出力内容:

吾輩は猫である。

stripメソッドを通してみると、両端にあった空白文字が取り除かれていることが確認できます。

txt = ' 吾輩は猫である。\n\n' print(txt.strip())コード実行結果の出力内容:

吾輩は猫である。

第一引数に文字列を指定した場合には、その文字列で1文字ずつ両端で削除処理が実行されます。例えば引数に

猫犬という文字列を指定すれば、両端から猫もしくは犬という文字ではなくなるまで削除処理が実行されます。txt = '猫犬猫兎狼犬猫犬' print(txt.strip('猫犬'))コード実行結果の出力内容:

兎狼

lstripメソッドは、stripメソッドの左端のみ文字の削除処理が実行されるメソッドです。lはleftのlとなります。

使い方や引数などはstripメソッドと同じです。以下のコードでは右端の

猫と犬という文字が残っていることが確認できます。txt = '猫犬猫兎狼犬猫犬' print(txt.lstrip('猫犬'))コード実行結果の出力内容:

兎狼犬猫犬

rstripメソッドはlstripメソッドなどの流れから分かる通り、右端のみ文字の削除を行います。メソッド名の先頭のrはrightのrとなります。使い方はstripやlstripメソッドと同じです。

txt = '猫犬猫兎狼犬猫犬' print(txt.rstrip('猫犬'))コード実行結果の出力内容:

猫犬猫兎狼

文字列を全て大文字にする : upperメソッド

upperメソッドは文字列を全て大文字に変換します。アルファベットの文字列部分が変換対象となります。

upper caseで「大文字」という意味なので、メソッド名はそちらに由来します。

txt = 'Apple and orange' print(txt.upper())コード実行結果の出力内容:

APPLE AND ORANGE

半角文字だけでなく全角文字でも同様に変換することができます。

txt = 'Apple' print(txt.upper())コード実行結果の出力内容:

APPLE

文字列を全て小文字にする : lowerメソッド

lowerメソッドはupperメソッドとは逆に、アルファベットの大文字の文字列部分を小文字に変換します。lower caseで「小文字」という意味なので、メソッド名はそちらに由来します。

大文字と小文字の変換が逆なだけで、使い方や挙動はupperメソッドと同じです。

txt = 'Apple And Orange' print(txt.lower())コード実行結果の出力内容:

apple and orange

数字の文字列をゼロ埋めする : zfillメソッド

任意の整数を、特定の文字数になるまで左側に0を追加する処理をゼロ埋めもしくはゼロパディング(zero padding)と言います。

例えば

135という文字を5文字に揃えるゼロ埋めをすると、00135となります。zfillメソッドは、このゼロ(zero)埋め(fill)の処理をしてくれます。第一引数には結果の文字数を整数で指定します。5を指定したら5文字になるまで0が付与され、7を指定したら7文字になるまで0が付与されます。

txt = '135' print(txt.zfill(5))コード実行結果の出力内容:

00135

文字列を特定の文字数になるまで文字を追加する : rjust, ljust, centerメソッド

rjust、ljust、centerメソッドもzfillと同じように任意の文字数になるまで文字を埋める挙動をします。ただし、zfillと以下の挙動が異なります。

- 埋める文字は0ではなく任意の文字を指定することができます。

- メソッドによって、埋める文字の位置を左端、右端、もしくは両端を選択できます。

rjustメソッドは文字列は右に配置され、左端に任意の文字が埋められます。right justifyingで「右ぞろえ」という意味であり、メソッド名はそちらに由来します。

第一引数に最終的な文字数の整数、第二引数に埋める文字を指定します。

txt = '犬犬' print(txt.rjust(5, '猫'))コード実行結果の出力内容:

猫猫猫犬犬

ljustメソッドは元の文字列は左ぞろえに配置され、右側に不足している数だけ文字が埋められます。

txt = '犬犬' print(txt.ljust(5, '猫'))コード実行結果の出力内容:

犬犬猫猫猫

centerメソッドは元の文字列は中央ぞろえに配置され、左端と右端両方に腹側している数がけ文字が埋められます。

txt = '犬' print(txt.center(5, '猫'))コード実行結果の出力内容:

猫猫犬猫猫

左右に埋める文字の数が奇数の場合は、左端の方が多く埋められます。

txt = '犬' print(txt.center(5, '猫'))コード実行結果の出力内容:

猫猫犬猫猫

先頭の1文字を大文字にして他を小文字にする : capitalizeメソッド

重要度 : ★★☆☆☆(最初は知らなくてもいいかも)

※以降の文字列操作のセクションは、比較的マイナーなものが多くなります。一応一通り触れていきますが、スキップいただいても大きな問題はありません。

capitalizeメソッドはアルファベットで先頭の一文字を大文字に変換し、その他を小文字に変換します。英語の文章などで便利です。

capitalizeという単語自体は「資本化する」といったようなお金関係の意味の他にも「大文字で始める」といった意味もあり、メソッド名はそちらに由来します。

txt = 'apple and orange' print(txt.capitalize())コード実行結果の出力内容:

Apple and orange

小文字だけが変換されるというわけではなく、文字列中に大文字が含まれている場合には先頭の1文字以外は大文字から小文字へと変換されます。

txt = 'APPLE AND ORANGE' print(txt.capitalize())コード実行結果の出力内容:

Apple and orange

各英単語の最初の1文字を全て大文字にする : titleメソッド

titleメソッドはアルファベットの各単語の先頭の一文字を大文字にし、他を小文字に変換します。

英文ではタイトルや見出しなどでは「主な単語の先頭の1文字を大文字にし、残りを小文字表記にする」という書き方がされることが多くあり、このような書き方をタイトルケース(title case)と呼びます。titleメソッドの名前の由来はタイトルケースに由来します。

注意点として、通常は

andやtheなどの単語は小文字のままで、名詞などの単語は先頭を大文字にする形(例えばApple and Orangeといったような形)でタイトルケースが反映されますが、Pythonのtitleメソッドは全ての単語で最初の1文字が大文字になります。txt = 'apple and orange' print(txt.title())コード実行結果の出力内容:

Apple And Orange

大文字と小文字を入れ替える : swapcaseメソッド

swapcaseメソッドは小文字部分を大文字にし、大文字部分を小文字にします。swapは「交換する」といった意味を持ちます。

txt = 'Apple And Orange' print(txt.swapcase())コード実行結果の出力内容:

aPPLE aND oRANGE

全ての文字列が大文字かどうか調べる : isupperメソッド

isupperメソッドは文字列内のアルファベットが全て大文字の場合に真偽値のTrueを返し、それ以外の場合にはFalseを返却します。他のセクションで触れた通り、

upper caseで大文字という意味なので、「文字列 is upper case」といった意味合いで真偽値を返す形でメソッド名がisupperとなっています。txt = 'APPLE AND ORANGE' print(txt.isupper())コード実行結果の出力内容:

True

文字列中に小文字が含まれているとTrueではなくFalseが返却されます。

txt = 'Apple And Orange' print(txt.isupper())コード実行結果の出力内容:

False

全ての文字列が小文字かどうか調べる : islowerメソッド

islowerメソッドはisupperメソッドとは逆で、文字列のアルファベットが全て小文字の場合に真偽値のTrueを返します。

lower caseで小文字という意味になります。txt = 'apple and orange' print(txt.islower())コード実行結果の出力内容:

True

1文字でも大文字が含まれていればFalseとなります。

txt = 'Apple and Orange' print(txt.islower())コード実行結果の出力内容:

False

なお、isupperメソッドも同様ですが大文字のアルファベット以外の記号や日本語などが含まれていてもそれらは判定に影響しません。あくまで小文字が含まれている文字列であり且つ大文字が含まれていないという条件になります。

txt = 'apple リンゴ' print(txt.islower())コード実行結果の出力内容:

True

各単語の最初の1文字が全て大文字・他が小文字になっているかを調べる : istitleメソッド

istitleメソッドは少し前のtitleメソッドのセクションで触れた(厳密ではありませんが)タイトルケース(各単語の先頭の1文字が大文字)かどうかの真偽値を返します。

txt = 'Apple And Orange' print(txt.istitle())コード実行結果の出力内容:

True

いずれかの単語で先頭が大文字になっていない単語があると結果はFalseになります。

txt = 'Apple and orange' print(txt.istitle())コード実行結果の出力内容:

False

文字列が全て英数字などになっているかどうかを調べる : isdecimal, isdigit, isnumeric, isasciiメソッド

このセクションでは文字列の内容が特定の文字列かどうか(10進数の整数のみの文字列かどうか、アルファベットのみの文字列かどうかなど)の判定用の真偽値を取得する各メソッドについて学んでいきます。

isdecimalメソッドは文字列が10進数(普段の生活で使っている、0~9までの10個の数字での数値表現)で表すことができる整数の文字列かどうかの真偽値を返却します(

decimal numberで10進数という意味になります)。整数以外の小数(もしくは小数記号)などが含まれている場合にはFalseとなります。記号や日本語・英語などの整数以外が含まれていてもFalseとなります。たとえば150といった数値の文字列はTrueとなります。

txt = '150' print(txt.isdecimal())コード実行結果の出力内容:

True

全角であっても内容が整数のみであれば結果はTrueとなります。

txt = '150' print(txt.isdecimal())コード実行結果の出力内容:

True

整数以外の値、例えば小数点などが含まれているとFalseとなります。

txt = '3.14' print(txt.isdecimal())コード実行結果の出力内容:

False

記号や空白文字なども含まれているとFalseとなります。例えば以下のように左端にスペースなどが含まれていてもFalseとなってしまいます。もしそういった空白文字が入る可能性があるプログラムの場合には前のセクションで触れたstripメソッドなどを使って余分な空白文字の削除を行って処理すると判定で想定外の結果になったりすることを避けられます。

txt = ' 150' print(txt.isdecimal())コード実行結果の出力内容:

False

isdigitメソッドはisdecimalと近い挙動をするメソッドで、整数かどうかの真偽値を返します。ただしこちらは通常の

0~9の数字だけでなく、数値の周りを〇で囲っている①や②といった丸付き数字の文字や指数の文字(2の3乗の3部分など、上付きの小さい数字の文字)などの特殊な数字の文字が一部許容します(isdecimalメソッドよりもTrueになる条件が多くなります)。isdecimalが名前の通り10進数かどうかの判定の一方で、digitは「アラビア数字(123などの文字)」といった意味を持つので、isdigitは特殊な文字も含めてアラビア数字かどうかといった判定になります。

isdecimalと同様に通常の整数でTrueになるサンプル :

txt = '150' print(txt.isdigit())コード実行結果の出力内容:

True

isdecimalと同様に整数以外の文字が含まれているためFalseになるサンプル :

txt = '150円' print(txt.isdigit())コード実行結果の出力内容:

False

特殊な

①などの丸付き文字でもTrueになることを確認するサンプル :txt = '①②' print(txt.isdigit())コード実行結果の出力内容:

True

特殊な

²などの指数部分の文字でもTrueになることを確認するサンプル(変換などはやりづらい文字なので、コード実行の際にはコードサンプルのコピーなどをお願いします) :txt = '²³⁴' print(txt.isdigit())コード実行結果の出力内容:

True

isnumericメソッドではさらに、isdigitメソッドの「アラビア数字の文字」という制限が無くなります(isdigitよりも多くの文字が対象になります)。文字列が全て数字を表す文字であればTrueになります。

アラビア数字という制約が無くなるので、例えば

Ⅲといったローマ数字でもTrueが返ります。txt = 'ⅠⅢⅥ' print(txt.isnumeric())コード実行結果の出力内容:

True

他にも漢字の文字列でもTrueになってくれます。

txt = '七五三' print(txt.isnumeric())コード実行結果の出力内容:

True

isasciiメソッドはASCIIコードと呼ばれる文字、例えば半角の英数時や一部の記号(

@の記号など)、改行などの特殊文字のみで文字列が構成されている場合にTrueを返却します。txt = '~@abcABC123' print(txt.isascii())コード実行結果の出力内容:

True

全角文字などではFalseが返却されます。

txt = 'ABC' print(txt.isascii())コード実行結果の出力内容:

False

他にもisalphaやisalnumなどのメソッドも存在しますが、こちらは利用頻度が少ない印象なのと、名前的にアルファベット(英字)かどうか(isalpha)、英数字かどうか(isalnum)に思えますが、漢字などの全角文字も対象となる少し直観に反したものになっているためここでは説明を割愛します。

文字列が全て空白文字かどうか調べる : isspace

isspaceメソッドは、文字列が全て空白文字になっているかどうかの真偽値を返却します。空白文字は半角スペースや全角スペース・改行(文字列中では

\nと表記されることも多くあります)・タブ(こちらも文字列中では\tと表記されることも多めです)などが該当します。txt = ' \n\t' print(txt.isspace())コード実行結果の出力内容:

True

スペースなどが含まれていても、空白文字以外が文字列中に存在するとFalseになります。

txt = '猫犬 \n\t' print(txt.isspace())コード実行結果の出力内容:

False

文字コードの変換を行う : encode. decodeメソッド

encodeメソッドとdecodeメソッドは文字列の文字コードを変換します。基本的にPythonでテキストを扱う場合にはUTF-8と呼ばれる文字コードがほぼほぼですが、古いファイルや環境、ファイルフォーマットなどによっては他の文字コード(Shift_JISなど)を扱わないといけないケースがたまに発生します。

ただし、文字列のencodeやdecodeメソッドを利用するというよりかは、テキストファイルなどの読み書き時にこれらの文字コードを指定するケースが多めです。

文字列自体のメソッドはあまり使うケースが少ないとは思いますので、ここでは軽く触れる程度に抑えておきます(ファイル操作などは後々の章でしっかりと学びます)。

まずはencodeメソッドからです。encodeメソッドではPython上の通常の文字列から、特定の文字コードの値に変換します。変換後の値はbytesクラスのインスタンスとなり、たとえばShift_JISに変換すると

\x94Lといった値になり、ぱっと見では読めない値になってしまいます。encodeメソッドの第一引数には文字コードを指定します。今回はShift_JISに変換しようと思いますので、

sjisという値を指定します(他にもutf-8などの決まった値が色々あります)。txt = '猫犬' sjis_txt = txt.encode('sjis') print('テキストの内容:', sjis_txt, '\n型:', type(sjis_txt))コード実行結果の出力内容:

テキストの内容: b'\x94L\x8c\xa2' 型: <class 'bytes'>

decodeメソッドはencodeメソッドと逆の動作をします。つまりShift_JISなどの文字コードに変換された値を、再びPython上で使える普通の文字列(

猫犬といったように、人が普通に読める文字列)に戻します。第一引数には対象の値が何の文字コードなのかを指定します。txt = sjis_txt.decode('sjis') print(txt)コード実行結果の出力内容:

猫犬参考文献・サイトまとめ

- 「関数」と「メソッド」の違い

- Pythonで文字列・数値を右寄せ、中央寄せ、左寄せ

- Pythonで大文字・小文字を操作する文字列メソッド一覧

- Python, formatで書式変換(0埋め、指数表記、16進数など)

- Pythonで文字列が数字か英字か英数字か判定・確認

- Python strip・lstrip・rstrip 空白を削除する

- Pythonで文字列を置換(replace, translate, re.sub, re.subn)

- Pythonで文字列・数値をゼロ埋め(ゼロパディング)

- Python 文字を検索し値を返す(find/index)

- 文字の変換にはstr.translate()が便利

- Comma-Separated Values

- Pythonで文字列を分割(区切り文字、改行、正規表現、文字数)

- 改行の、\nと\r\nの違いは何ですか?

- Python String partition()

- プログラマが持つべき心構え (The Zen of Python)

- PEP 3101 -- Advanced String Formatting

- what is the meaning of colon in python's string format?

- What is difference between str.format_map(mapping) and str.format

- PEP 498 -- Literal String Interpolation

- string --- 一般的な文字列操作

- Definition and Examples of Title Case and Headline Style

- 文字列の中の文字が数を表す文字かどうかを判定する(isdecimal, isdigit, isnumeric)

- [Python] 文字列が数字であることを判別する(isdigit, isdecimal, isnumeric)

- 文字列の中の文字が英字を表す文字かどうかを判定する(isascii, isalpha, isalnum)

- 投稿日:2020-07-28T19:58:26+09:00

discord.pyを使ってbotを作ったときの知見

プリコネのクラバト管理botを作ったのでそのへんで気づいたことです

https://github.com/izmktr/yukarisanon_readyでのイベント

on_readyはdiscordに接続したときに呼び出されます

また、不定期にdiscordから切断されるようで、

自動的に再接続したときにも呼び出されます。ここでは内部的に持っている情報とdiscord.pyのデータを結びつけると良さそうです。

import discord from discord.ext import tasks from typing import List, Dict, Optional #guild_idと内部的なクラスとの紐付け guildhash: Optional[Dict[int, GuildData]] = None @client.event def on_ready(): global guildhash if guildhash is None: # ロード処理 guildhash = {} for g in client.guilds: gdata = guildhash.get(g.id) if gdata is None: gdata = GuildData() guildhash[g.id] = gdata gdata.guild = gメッセージに付随する処理

リアクションを付ける/外すときに発生する、

on_reaction_add,on_reaction_remove ですが、呼び出されないことがあります。

大体、投稿されて15分程度経った後のメッセージでは反応しないことがあります。

(サーバの活発度によるのではないかと考えています)

おそらく、こうなるとon_message_deleteも飛んでこない気がします。max_messagesが1000なので大きくすれば回避できるかと思いましたが、

こんな感じで100000を入れてみても回避できませんでした。

(この辺の知見求む)# 意味がない? client = discord.Client(max_messages = 100000)on_raw_reaction_add,on_raw_reaction_remove を使えば、確実に飛んできます。

on_messageでmessageの情報を保存しておき、on_raw_reaction_~を使って

処理を解決するのがいいでしょう。なお、on_raw_reaction_add → on_reaction_addの順で呼び出されます。

on_reaction_add が飛んできたらこちらで、飛んでこないならon_raw_reaction_addと考えてましたが、

順序が逆なのでこの処理は面倒そうです。プライベートチャット

botにメッセージを送ることでbotとプライベートチャットができます。

開発用のコマンドを使う場合はプライベートチャットを使えば、

周りにログが見られない形で作業が行なえます。@client.event async def on_message(message): # メッセージ送信者がBotだった場合は無視する if message.author.bot: return # 通常のメッセージ if message.channel.type == discord.ChannelType.text: return # 1:1のメッセージ if message.channel.type == discord.ChannelType.private: return問題は、通常のメッセージとmessageの型が違います

ですから、なくなっているクラス変数やクラス関数があります。また、プライベートメッセージではギルドがありませんので、

プライベートメッセージ内でギルドを指定する必要があります。この差異を吸収するような設計にして各種コマンドの処理を作っておくと

便利だっただろう、という反省点です。

- 投稿日:2020-07-28T19:57:12+09:00

Arduino UNO : USB2UARTの最大通信速度を探る(1)

Arduino UNOのUSB2UART最高速度は115200bps ??

各場所を調べてもArduinoのUART最高速度は115200で、それ以上は保証しないと書かれています。

しかし、私が試している限りでは921600bpsを設定しても普通に通信ができています。

下記サイトを見ると、500000bpsで通信速度自体は頭打ちとのオシロ上での測定結果もあります。

https://arduino.stackexchange.com/questions/296/how-high-of-a-baud-rate-can-i-go-without-errors

Arduino UNO USB2UARTで実際にはどれくらいのスピードで通信できるか測定してみます。Arduino UNO部品レベルの限界値

ここでArduinoは Arduino UNO R3(Revision3)前提となります。

外付けOSCとATmega328P、USB2UART ICの設定を見てみます。

回路図は下記よりダウンロードできます。

https://www.arduino.cc/en/uploads/Main/Arduino_Uno_Rev3-schematic.pdfATmega328Pがメインマイコンとなります。

メインクロックは16MHzの水晶が搭載されています。

この関係から、ATmega328Pに接続されるUARTは Max 2Mbpsまで可能だと思われます。

FTDIのUSB2UARTチップを外付けで使えばこのスピードで通信が可能となります。Arduinoの場合USB通信(Virtual Com Port)用に ATmega16U2が搭載されています。

このマイコンがUART⇔USB変換と、FW書き込みを担っていると思われます。

メインクロックは16MHzの水晶が搭載されています。

こちらのUART通信最高速度は2Mbpsです。ATmega328PとATmega16U2がUART接続されているため、

システム全体では2Mbpsが最高速度となっていると思われます。通信時間確認プログラムを作る

この通信速度を計測するプログラムを作成してみます。

1byteを相互に通信しあうプログラム

それぞれに対して100kbyte送信するまでの時間を測定します。100kbyte * 2(送受信) * 8(bit) / 秒数 = ??? bps

Arduino側送受信

SpeedText.ino#include <Wire.h> #define BAUDRATE 500000 char buffer[0x10]; void setup() { Wire.begin(); Serial.begin(BAUDRATE); } void loop() { if (Serial.available() > 0) { buffer[0] = Serial.read(); Serial.write('!'); } }PC側送受信 (Python)

SpeedText.pyimport sys import serial import time from StopWatch import * datasize = 1024*100 if __name__ == "__main__": print("Arduino USB Speed Test") sw1 = StopWatch("No1") ser = serial.Serial() ser.baudrate = 500000 com_str = 'COM3' ser.port = com_str ser.open() time.sleep(2) print("start") sw1.start() for i in range(datasize): ser.write(str.encode("!")) data = ser.read(1) print(sw1.name + ":" + str(sw1.stop())) print("finesh")測定結果

209.718秒

計算してみると、1024*100 * 2 * 8 / 209.718 = 7812bps

50000bpsを設定しているのになかなかの遅さです。他のボーレートでも通信速度確認してみる。

115200bpsを設定してみても、計測結果は209.7144秒とほぼ一緒。

57600bpsを設定すると、419.4265秒とほぼ倍。 約3906bps

という事で、Web情報通りにArduinoは115200bpsがUSB-UART接続を使った場合の最大速度だと思われます。Virtual COM Port Driverは2Mbps設定可能で、実際通信ができます。

ただ、どこかの通信経路がボトルネックとなるか、別途調べてみたいと思います。

- 投稿日:2020-07-28T17:45:49+09:00

【Python】AttributeError: 'list' object has no attribute 'replace'

Pythonのスクレイピングを勉強中、値の加工をしていたら

AttributeError: 'list' object has no attribute 'replace'が出たので、メモで対策を残しますエラーが出た原因

Pythonで取得したlistに、特定の文字列を削除するロジックを書こうとしていました。

しかし、str_list = ['aaabbb','article'] str_list_new = str_list.replace('a', '')出力結果

AttributeError: 'list' object has no attribute 'replace'対策

配列を一旦単独の文字列に変換してから、replace()で置換、のちに配列に戻すという処理をすればいいらしいです。

str_list = ['aaabbb','article'] string = ",".join(str_list) string_new = string.replace('a', '') str_list_new = string_new.split(",") print(string_new)

- 投稿日:2020-07-28T17:23:26+09:00

OCRエンジンのTesseract(テッセラクト)を用いて画像ファイル内のテキストを抽出してみた

背景

画像ファイル(帳票データのスキャン)から、Tesseract(テッセラクト)を用いて、テキストデータをサクッと抽出できたので、備忘録として、整理した。

- Tesseract(テッセラクト)は、日本語にも対応したOCRエンジン

- オープンソースでライセンス(関連記事1.)は「Apache License 2.0」ということで、商用利用も可能

- Tesseract 4 からは、RNN (Recurrent Neural Network) を拡張したLSTM(Long short-term memory)をベースとしたOCRエンジン(AI-OCR)も搭載されており、これを利用することで、抽出精度も期待できる(と思う)

- サポート言語は、『tesseract/doc/tesseract.1.asc』 から数えたところ、117個存在した(2020/7/25時点)

1.導入

- 最初に、『tesseract-ocr/tesseract』 を参照

- その中で、Window環境においては、参照先からリンクされている Tesseract at UB Mannheim の older versions から、最新(v5)の安定版用(tesseract-ocr-w64-setup-v5.0.0.20190623.exe)のインストーラーをダウンロード

- その後の作業は、『Tesseract OCR をWindowsにインストールする方法(関連記事2.』)を参考に実施

2.実行

- 実行においては、テストデータとして、【エクセル・マクロ】VBA+OCRで画像内のテキストを抽出するで紹介されている、テスト画像データを活用

- 実行に先立って、実行用に『PythonでOCRを実行する方法(関連記事3.)』を参考に、pythonコードを作成

- pythonからtesseractを利用するには、PyOCRパッケージが必要

- このパッケージを利用することで、よりテキストの抽出精度が向上(ゴミ削除)が可能(のようである)

- 実行結果を以下に記載

C:\Users\xxx\work>python ocr_card.py test_data_3.png 画像上に記載されている文字列をプログラムで解析し、テキストだけを文字列として取得することが可能です!今回は、間料です友に 偽え、それをりの若六は見ふめる、をんな文字認識方法を紹介しだいと思います。 画像上に記載されている文字列を プログラムで解析し、テキストだ けを文字列として取得することが 可能です! 今回は、間料です友に偽え、それ をりの若六は見ふめる、をんな文 字認識方法を紹介しだいと思いま す。

- さらに、『【Pyocr+TesseractOCR】競馬新聞の活字化;精度向上♬(関連記事4.)』を参考に、画像データのサイズを拡大

- この結果、少なくとも空白行が除去されていた

C:\Users\xxx\work>python ocr_card.py test_data_3_mod.png 画像上に記載されている文字列をプログラムで解析し、テキストだけを文字列として取得することが可能です!今回は、和科料て考醤 に偽え、それをりの若病は見人ふめる、才んな文字認識方法を紹介しだいと思います。 画像上に記載されている文字列を プログラムで解析し、テキストだ けを文字列として取得することが 可能です! 今回は、和科料て考醤に偽え、それ をりの若病は見人ふめる、才んな文 字認識方法を紹介しだいと思いま す。

- その他、Tesseract の理解には、『八谷大岳の覚え書きブログ(関連記事5.)』が参考になる

- また、PDFファイルから画像データを抽出して保存(変換)するには、『PythonでPDFを画像ファイル(JPEG、PNG)に変換する方法(関連記事6.)』 が参考になる

3.考察

- 明朝フォント、ゴシックフォントにおいては、正しく画像内のテキストが抽出できている

- その他フォントでは、誤抽出が目立っている

- このことから、他の日本語フォントでは、おそらく学習データがなくトレーニングされていないと考えられる ⇒ したがって、画像原本内で利用されているフォントを学習させることで、誤抽出の削減が期待できる

- また、画像を拡大することで、最初の実行結果である空白行(誤抽出)の削除に繋がっている ⇒ したがって、画像データを少しでも拡大することで、より誤抽出の削減に期待できる

4.精度向上

では、どうやって精度を上げていくか?

・独自に学習データを作成して学習させる

素人的に考えられる方法としては、次のとおり。しかし、こういったことができるのか、ツール(今回は、Tesseract(テッセラクト))を調べる必要がある。

(1) 手書きの場合 ⇒ 画像原本内の手書き文字の特徴(クセ)を反映した学習データを準備し学習させる。

・『Tesseract 4.1にLSTMを使って手書き文字を再学習させる(関連記事7.)』

・『【23個掲載】OCR(光学式文字認識)・手書き文字認識データセットまとめ(関連記事8.)』(2) 画像原本内で使われているフォントを学習データとして用意して、学習させる

・すぐにでもできる方法

『【SikuliX】OCRの日本語読み取り精度を上げる3つの方法(関連記事9.)』に記載されている、次の3つを試してみることで精度向上が期待できる(と思われる)

(1)適切な文字サイズに画像を拡大して読み取る

(2)できるだけ高解像度の画像を用意する

(3)ブラックリスト、ホワイトリストを設定する関連記事

1.OSSのライセンスを理解する(「使用」と「利用」の違い、知っていますか?)

2.Tesseract OCR をWindowsにインストールする方法

3.PythonでOCRを実行する方法

4.【Pyocr+TesseractOCR】競馬新聞の活字化;精度向上♬

5.八谷大岳の覚え書きブログ

6.PythonでPDFを画像ファイル(JPEG、PNG)に変換する方法

7.Tesseract 4.1にLSTMを使って手書き文字を再学習させる

8.【23個掲載】OCR(光学式文字認識)・手書き文字認識データセットまとめ

9.【SikuliX】OCRの日本語読み取り精度を上げる3つの方法

10.Documentation of Tesseract OCR

11.tesseract-ocr/tesseract

12.PythonとTesseract OCRで文字認識

13.Tesseract 4.1にLSTMを使って日本語を再学習させる

14.甲骨文字で書かれた文章をOCRで読み取れるようにしてみる

15.文字認識エンジンTesseract OCRで学習

16.jTessBoxEditorでTesseractの学習データを作成する

17.Tesseract+PyOCRで簡易OCRを試してみる

18.PyOCRでTesseractを使う

19.罫線の無い 10 行 10 列の等間隔整列した文字の画像を大きくリサイズして ocr してみる(Python + Tesseract)

20.tesseractコマンドの使い方(Tesseract OCR 4.x)

21.tesseract のオプション PSM をいじってみた

22.Pythonで書くTesseract 4の基本的な使い方。APIとCLIからOCRを実行する方法

- 投稿日:2020-07-28T17:16:12+09:00

顔認識とPCAとK-meansクラスタリングを用いた似た顔画像検出

はじめに

似た画像の検出は画像認識におけるよく利用される機能の一つです。

レコメンドシステムや検索システムでは数万、数十万という画像を利用することも少なくありません。

画像のサイズや比較方法にもよりますが、数千、数万枚のなかから似た画像を検索するのは膨大な処理時間が必要になります。

そこでk-meansとPCAを利用してデータ量や比較回数を削減して似た画像を検出する方法を考えます。Face Recognition

顔の特徴は以下のURLのライブラリで実装できる、128次元のベクトルで表されるface_landmarkを利用します。

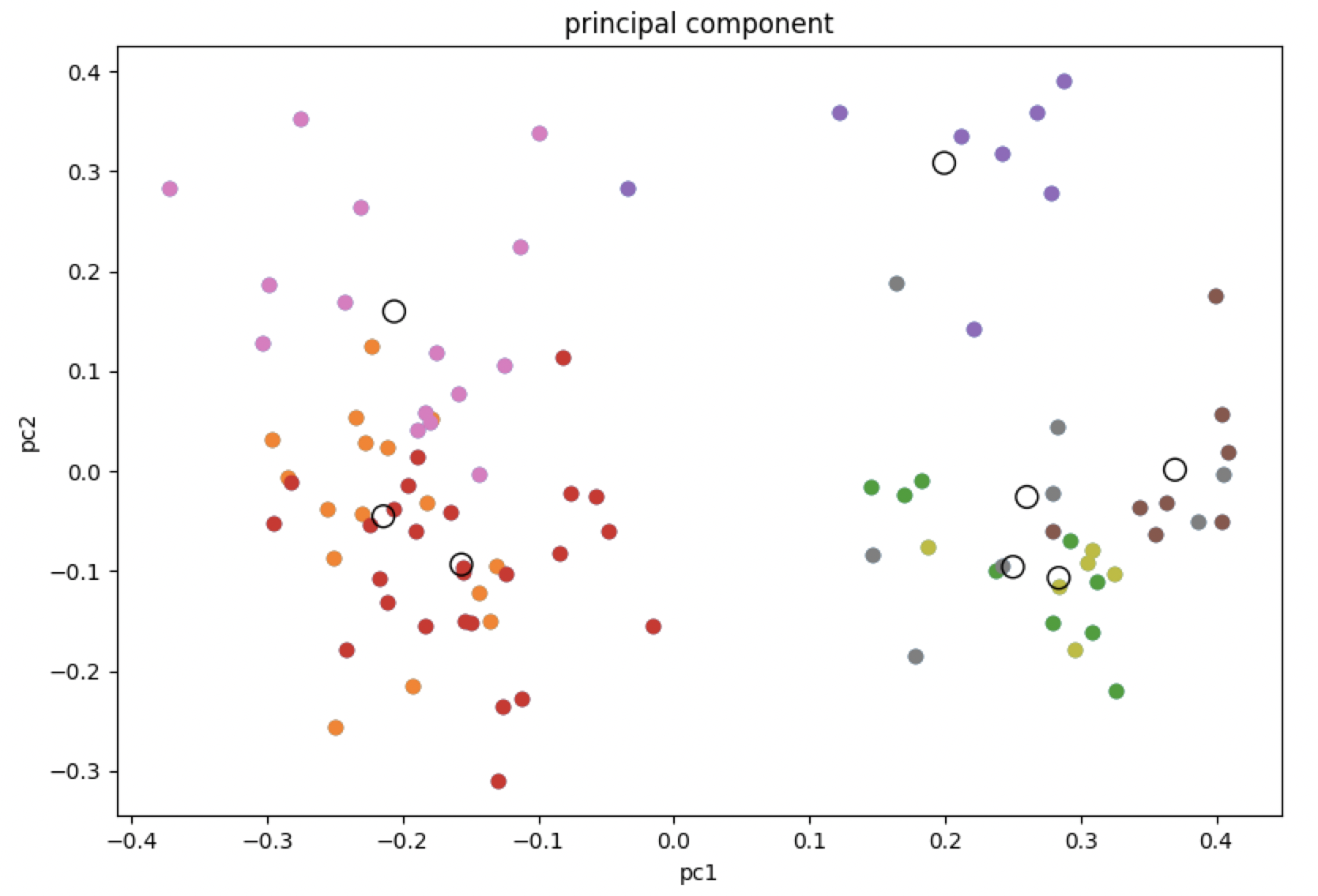

https://github.com/ageitgey/face_recognitionPCA後の次元数は寄与率を見つつ20としました。PCAを行って次元削減をした後にk-meansによってK=10のクラスタに分類します。

各クラスタの重心から最も近いものを算出し、最も重心が近いクラスタに分類された画像のみ距離を算出して似た画像を検出します。

また、画像の特徴をPCAで削減したデータで保存することで保存容量の削減にも有効です。1000枚の画像を利用した場合、k-means方によるクラスタリングによって平均100回+10回(各クラスタの重心との比較)の比較で済むようになります。

また各ベクトルの次元数もPCAによって128次元から20次元に削減されているため、効果的に計算量を削減することができます。http://mmlab.ie.cuhk.edu.hk/projects/CelebA.html

今回はこちらのフリーの顔画像を利用したサンプルソースを下記します。プログラム

# coding:utf-8 import dlib from imutils import face_utils import cv2 import glob import face_recognition from sklearn.decomposition import PCA from sklearn.cluster import KMeans from matplotlib import pyplot as plt import numpy as np # -------------------------------- # 1.顔ランドマーク検出の前準備 # -------------------------------- # 顔検出ツールの呼び出し face_detector = dlib.get_frontal_face_detector() # 顔のランドマーク検出ツールの呼び出し predictor_path = 'shape_predictor_68_face_landmarks.dat' face_predictor = dlib.shape_predictor(predictor_path) images = glob.glob('./faces/*.jpg') images = sorted(images)[:100] face_landmarks = [] face_filepaths = [] for filepath in images: # 検出対象の画像の呼び込み img = face_recognition.load_image_file(filepath) face_encodings = face_recognition.face_encodings(img) if (len(face_encodings)>0): face_filepaths.append(filepath) face_landmarks.append(face_encodings[0]) pca = PCA(n_components=20) pca.fit(face_landmarks) # 分析結果を元にデータセットを主成分に変換する transformed = pca.fit_transform(face_landmarks) # 主成分をプロットする # plt.subplot(1, 2, 2) plt.scatter(transformed[:, 0], transformed[:, 1]) plt.title('principal component') plt.xlabel('pc1') plt.ylabel('pc2') # 主成分の次元ごとの寄与率を出力する print(pca.explained_variance_ratio_) print(sum(pca.explained_variance_ratio_)) # print(transformed[0]) # print(len(transformed[0])) # Kmeans開始 # クラスター数 K = 8 cls = KMeans(n_clusters = 8) pred = cls.fit_predict(transformed) # 各要素をラベルごとに色付けして表示する for i in range(K): labels = transformed[pred == i] plt.scatter(labels[:, 0], labels[:, 1]) # クラスタのセントロイド (重心) を描く centers = cls.cluster_centers_ plt.scatter(centers[:, 0], centers[:, 1], s=100, facecolors='none', edgecolors='black') # どの重心に一番近いかを検索 min_center_distance = -1 min_center_k = 0 # どの重心に一番遠いかを検索 max_center_distance = -1 max_center_k = 0 for center_index in range(K): distance = np.linalg.norm(transformed[0] - centers[center_index]) if ( distance < min_center_distance or min_center_distance == -1): min_center_distance = distance min_center_k = center_index if ( distance > max_center_distance or max_center_distance == -1): max_center_distance = distance max_center_k = center_index # 一番近いクラスタと一番遠いクラスタの画像名を表示 print('=========== NEAREST ==============') for i in range(len(pred)): if ( min_center_k == pred[i] ): print(face_filepaths[i]) print('=========== FARTHEST ==============') for i in range(len(pred)): if ( max_center_k == pred[i] ): print(face_filepaths[i]) print('=========================') # グラフを表示する plt.show() # ※これ以下は蛇足 # 各画像との直接的な距離を算出する distance = {} for index in range(len(transformed)): distance[face_filepaths[index]] = np.linalg.norm(transformed[0] - transformed[index]) # 距離順にソートして表示 print(sorted(distance.items(), key=lambda x:x[1]))クラスタリング結果グラフ

重心を空洞の円で各クラスタに分けられた画像の特徴を色分けして表示しています。

20次元のグラフを2次元にプロットしているので少し分かりにくいですが、主成分である程度近いもの同士をまとめてクラスタリングしていることがわかります。

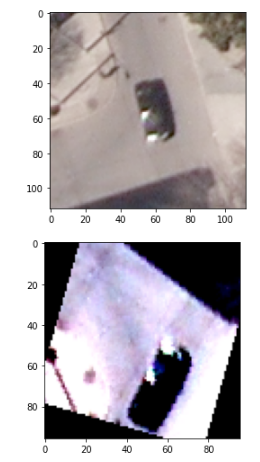

分析結果

分析のベースにした画像

1.jpg 同じクラスタに含まれていた画像

10.jpg 11.jpg 19.jpg 24.jpg 重心が一番遠いクラスタに含まれていた画像

12.jpg 37.jpg 51.jpg 60.jpg 結果考察

同じクラスタに分けられた画像は長髪の女性が多く、一番遠いクラスタに分けられた画像は短髪の男性が多く、人間の感覚と似たようなクラスタリングができたと思います。

より厳密に近い画像を得たい場合は、主成分分析をせずに直接ノルムを全画像と算出をするべきですが、セレンディピティを狙ったり、より早い計算を実現するためには今回用いいたような手法を検討しても良さそうです。

- 投稿日:2020-07-28T16:29:29+09:00

PythonのCMSはWagtailが一番だ!(多分)

記事の内容

pythonのCMSとして、

なんかが挙げられると思います。

その中で、

PythonでCMS、どれ使えばいいの?

を参考に、どれを使おうかなと悩んでいた場合、参考になるのではないかと思います。経験

CMSを使わずに、djangoで開発経験がありました。

この時、使っていたのはdjango2系です。結論

django CMS は、まだ使ったことがないので

Mezzanine vs Wagtail

でやりたいと思います。結論としては、Wagtailをお勧めします。

なぜなら、(僕が知る限り)Mezzanineは、Djnago1系がベースなためです。

WordPressに慣れ親しんだ方であれば、確かに使いやすくとても便利ですが、

Django1系が2系以降とあまりにも互換性がないと感じまして、開発しずらいと思ました。その点、wagtailはdjango2系以降も対応しているため、Mezzanineよりはいいのではないかと思います。

ただし、Wagtailの日本語資料が非常に少ない点は残念ですが、Youtubeにまとめている方

がいっらしゃったので、そちらを参考に頑張ってみてください。

英語がわからなくても、ソースコードと実行画面を見るだけでやりたいことは実装できるかと思います。参考文献

- 投稿日:2020-07-28T15:50:01+09:00

プログレスバーの表示方法 (tqdm)

基本情報

tqdmを使うとfor文などの、時間のかかる処理で進捗を確認するための、プログレスバーを簡単に表示できる。

インストールが必要

$ pip install tqdm使い方

使い方はイテラブルオブジェクトをtqdmで囲むだけです。

tqdm_test.pyfrom tqdm import tqdm df = pd.read_csv("データ.csv", encoding="UTF-8") #pandasのデータをfor文処理する場面を考える #tqdmの使い方はtqdmで囲むだけ for row, item in tqdm(df.iterrows()): print(item)備忘録

手動でプログレスバーの数値を設定する方法

今まで私は上記の方法しか使ったことがありませんでした。

しかし、なぜかプログレスバーの上限が「?」になってしまう現象が発生したため、

手動で上限の数を設定する方法を調べたので、自分用の備忘録として記載しておきます。tqdm_test.pyfrom tqdm import tqdm df = pd.read_csv("データ.csv", encoding="UTF-8") #with文で囲み、for文の最後にプログレスバーを手動でupdateする方法 #total=で上限を設定。今回はdfの件数にした。増加分は.pbar.updateで指定する。 with tqdm(total=len(df)) as pbar: for row, item in tqdm(dataframe.iterrows()): print(item) pbar.update(1)jupyternotebookの場合に

from tqdm.notebookとすると簡単に見やすいプログレスバーになった。tqdm_test.pyfrom tqdm.notebook import tqdm

- 投稿日:2020-07-28T15:46:30+09:00

【Python】TypeError: 'in <string>' requires string as left operand, not list

Pythonのスクレイピングを勉強中、値の加工をしていたら

TypeError: 'in <string>' requires string as left operand, not listが出たので、メモで対策を残しますエラーが出た原因

Pythonで取得したlistに、該当する文字列がまれているかの、条件分岐をやろうとしていました。

if '該当させたい文字列' in i:そしたらこのエラーが出た

TypeError: 'in <string>' requires string as left operand, not list対策

リスト内包表記を使う

False not in [i in '該当させたい文字列' for i in 検索したい文字列の入ったリスト]参考

https://pg-chain.com/python-in

https://ai-inter1.com/python-if-in/

https://kuzunoha-ne.hateblo.jp/entry/2019/02/15/213000

- 投稿日:2020-07-28T15:24:10+09:00

Pandasメモ

Pythonの学習でPandask関連の内容があった場合は、随時更新していく予定。

インポート

import pandas as pdCSV操作

# CSV の読み込み [read_csv] csv_test_1 = pd.read_csv('hoge.csv') # データの先頭を表示 [head] csv_test_1.head()データの結合(ユニオン)

# データの縦結合 [concat] csv_test_2 = pd.read_csv('hoge_2.csv') csv_test = pd.concat([csv_test_1 , csv_test_2], ignore_index=True) csv_test.head() # データの結合 LEFT JOIN [merge] join_data = pd.merge(csv_test_1, cav_test2[["id", "date", "customer"]], on="id", how="left") join_data.head()データ列の作成

# aとbを掛け合わせた値を、追加列の new に設定する join_data["new"] = join_data["a"] * join_data["b"]

- 投稿日:2020-07-28T15:23:13+09:00

Python で CG 画質評価のメモ

背景

- モンテカルロレンダリングの結果が正しいのか(本当に収束しているのか)評価したい

- CG 画像と, 実写画像が一致するかどうか判断したい, 誤差(みたいなもの)を出したい.

Jupyter-lab + numpy/scipy とかでお手軽にぺろっとやりたい.

世の中の普通の(?)画像処理をする人向けではありません.

よくある方法

SSIM

skimage にある

https://scikit-image.org/docs/dev/auto_examples/transform/plot_ssim.html

SNR

scipy にあるようだが, 式自体は簡単なので numpy で書いたほうがよさそう

https://github.com/scipy/scipy/issues/9097

https://www.codespeedy.com/calculate-signal-to-noise-ratio-in-python/

CG 向けの方法

FLIP

ꟻLIP: A Difference Evaluator for Alternating Images

https://research.nvidia.com/publication/2020-07_FLIPHPG2020 で, できたてほやほや.

CG と実写の誤差算出などにも使えそうで我々のようなユーザによさげ.

numpy/scipy での実装含め, 各種言語での実装がある.

その他

Detecting Bias in Monte Carlo Renderers using Welch’s t-test

http://jcgt.org/published/0009/02/01/モンテカルロレンダリング向け.

こちらも python コードがありよい.

- 投稿日:2020-07-28T14:09:27+09:00

Pandasユーザーガイド「欠損データの操作」(公式ドキュメント日本語訳)

本記事は、Pandas の公式ドキュメントのUser Guide - Working with missing dataを機械翻訳した後、一部の不自然な文章を手直ししたものである。

誤訳の指摘・代訳案・質問等があればコメント欄や編集リクエストでお願いします。

欠損データの操作

このセクションでは、pandas の欠損値(NA)について説明します。

注

内部的にNaNを使用して欠落データを示すことを選択したのは、主に単純さとパフォーマンス上の理由によるものでした。pandas 1.0 以降、一部のオプションのデータ型は、マスクベースのアプローチを使用してネイティブNAスカラーを試行し始めます。詳細はこちらをご覧ください。「欠損」とみなされる値

データはさまざまな形や形式で存在するため、pandas は欠落データの処理に関して柔軟であることを目指しています。

NaNは計算速度と利便性の理由からデフォルトの欠損値マーカーですが、浮動小数点、整数、真偽値、および一般オブジェクトのさまざまなタイプのデータ型でこの値を簡単に検出できる必要があります。またしかし、多くの場合、Python のNoneも見られ、「欠落」または「利用不可」または「NA」も考慮する必要があります。

注

計算でinfと-infを「NA」と見なしたい場合は、pandas.options.mode.use_inf_as_na = Trueによって設定できます。In [**]: df = pd.DataFrame(np.random.randn(5, 3), index=['a', 'c', 'e', 'f', 'h'], ....: columns=['one', 'two', 'three']) ....: In [**]: df['four'] = 'bar' In [**]: df['five'] = df['one'] > 0 In [**]: df Out[**]: one two three four five a 0.469112 -0.282863 -1.509059 bar True c -1.135632 1.212112 -0.173215 bar False e 0.119209 -1.044236 -0.861849 bar True f -2.104569 -0.494929 1.071804 bar False h 0.721555 -0.706771 -1.039575 bar True In [**]: df2 = df.reindex(['a', 'b', 'c', 'd', 'e', 'f', 'g', 'h']) In [**]: df2 Out[**]: one two three four five a 0.469112 -0.282863 -1.509059 bar True b NaN NaN NaN NaN NaN c -1.135632 1.212112 -0.173215 bar False d NaN NaN NaN NaN NaN e 0.119209 -1.044236 -0.861849 bar True f -2.104569 -0.494929 1.071804 bar False g NaN NaN NaN NaN NaN h 0.721555 -0.706771 -1.039575 bar True(ときには異なるデータ型の配列を通して)欠損値の検出を容易にするために、pandasは

isna()およびnotna()関数を用意しています。これらは、Series および DataFrame オブジェクトのメソッドでもあります。In [**]: df2['one'] Out[**]: a 0.469112 b NaN c -1.135632 d NaN e 0.119209 f -2.104569 g NaN h 0.721555 Name: one, dtype: float64 In [**]: pd.isna(df2['one']) Out[**]: a False b True c False d True e False f False g True h False Name: one, dtype: bool In [**]: df2['four'].notna() Out[**]: a True b False c True d False e True f True g False h True Name: four, dtype: bool In [**]: df2.isna() Out[**]: one two three four five a False False False False False b True True True True True c False False False False False d True True True True True e False False False False False f False False False False False g True True True True True h False False False False False

警告

Python(およびNumPy)では、nanは同等ではなく、Noneは同等であることに注意する必要があります。pandas / NumPyはnp.nan != np.nanという事実を使用しながら、np.nanのようにNoneを扱うことに注意してください。In [**]: None == None # noqa: E711 Out[**]: True In [**]: np.nan == np.nan Out[**]: Falseしたがって、上記と比較して、

None/np.nanに対するスカラー等値比較は有用な情報を提供しません。In [**]: df2['one'] == np.nan Out[**]: a False b False c False d False e False f False g False h False Name: one, dtype: bool整数データ型と欠損データ

NaNは浮動小数点数であるため、欠損値が1つでもある整数の列は、浮動小数点数データ型に変換されます(詳細については、整数NAのサポートを参照してください)。pandasは、欠損値を含むことができる整数配列を提供します。これは、データ型を明示的に指定することで使用できます。In [**]: pd.Series([1, 2, np.nan, 4], dtype=pd.Int64Dtype()) Out[**]: 0 1 1 2 2 <NA> 3 4 dtype: Int64文字列エイリアス

dtype='Int64'(大文字の"I"に注意)を指定することでも使用可能です。詳しくは欠損可能整数データ型を参照してください。

時系列データ(datetime)

datetime64[ns] 型の場合、

NaTが欠損値を表します。これは、NumPyの単一のデータ型( datetime64[ns] )で表すことができる擬似ネイティブのセンチネル値です。pandasオブジェクトは、NaTとNaNの間の互換性を提供します。In [**]: df2 = df.copy() In [**]: df2['timestamp'] = pd.Timestamp('20120101') In [**]: df2 Out[**]: one two three four five timestamp a 0.469112 -0.282863 -1.509059 bar True 2012-01-01 c -1.135632 1.212112 -0.173215 bar False 2012-01-01 e 0.119209 -1.044236 -0.861849 bar True 2012-01-01 f -2.104569 -0.494929 1.071804 bar False 2012-01-01 h 0.721555 -0.706771 -1.039575 bar True 2012-01-01 In [**]: df2.loc[['a', 'c', 'h'], ['one', 'timestamp']] = np.nan In [**]: df2 Out[**]: one two three four five timestamp a NaN -0.282863 -1.509059 bar True NaT c NaN 1.212112 -0.173215 bar False NaT e 0.119209 -1.044236 -0.861849 bar True 2012-01-01 f -2.104569 -0.494929 1.071804 bar False 2012-01-01 h NaN -0.706771 -1.039575 bar True NaT In [**]: df2.dtypes.value_counts() Out[**]: float64 3 object 1 datetime64[ns] 1 bool 1 dtype: int64欠損データの挿入

コンテナに割り当てるだけで、欠損値を挿入できます。使用される実際の欠損値は、データ型に基づいて選択されます。

たとえば、与えられた欠損値の型に関係なく、数値コンテナは常に

NaNを使用します。In [**]: s = pd.Series([1, 2, 3]) In [**]: s.loc[0] = None In [**]: s Out[**]: 0 NaN 1 2.0 2 3.0 dtype: float64同様に、時系列コンテナは常に

NaTを使用します。オブジェクトコンテナの場合、pandasは与えられた値を使用します。

In [**]: s = pd.Series(["a", "b", "c"]) In [**]: s.loc[0] = None In [**]: s.loc[1] = np.nan In [**]: s Out[**]: 0 None 1 NaN 2 c dtype: object欠損データに対する計算

欠損値は、pandasオブジェクト間の算術演算を通じて自然に伝播します。

In [**]: a Out[**]: one two a NaN -0.282863 c NaN 1.212112 e 0.119209 -1.044236 f -2.104569 -0.494929 h -2.104569 -0.706771 In [**]: b Out[**]: one two three a NaN -0.282863 -1.509059 c NaN 1.212112 -0.173215 e 0.119209 -1.044236 -0.861849 f -2.104569 -0.494929 1.071804 h NaN -0.706771 -1.039575 In [**]: a + b Out[**]: one three two a NaN NaN -0.565727 c NaN NaN 2.424224 e 0.238417 NaN -2.088472 f -4.209138 NaN -0.989859 h NaN NaN -1.413542データ構造の概要(およびこちらとこちらのリスト)で説明されている記述統計と計算方法はすべて、欠損データを説明するために書かれています。例えば:

- データを合計するとき、NA(欠損)値はゼロとして扱われます。

- データがすべてNAの場合、結果は0になります。

cumsum()やcumprod()などの累積メソッドは、デフォルトではNA値を無視しますが、結果の配列には保持します。この動作をオーバーライドしてNA値を含めるには、skipna=Falseを使用します。In [**]: df Out[**]: one two three a NaN -0.282863 -1.509059 c NaN 1.212112 -0.173215 e 0.119209 -1.044236 -0.861849 f -2.104569 -0.494929 1.071804 h NaN -0.706771 -1.039575 In [**]: df['one'].sum() Out[**]: -1.9853605075978744 In [**]: df.mean(1) Out[**]: a -0.895961 c 0.519449 e -0.595625 f -0.509232 h -0.873173 dtype: float64 In [**]: df.cumsum() Out[**]: one two three a NaN -0.282863 -1.509059 c NaN 0.929249 -1.682273 e 0.119209 -0.114987 -2.544122 f -1.985361 -0.609917 -1.472318 h NaN -1.316688 -2.511893 In [**]: df.cumsum(skipna=False) Out[**]: one two three a NaN -0.282863 -1.509059 c NaN 0.929249 -1.682273 e NaN -0.114987 -2.544122 f NaN -0.609917 -1.472318 h NaN -1.316688 -2.511893空・欠損データにおける総和・総乗

警告

この動作は v0.22.0 現在の標準であり、numpyのデフォルトと一致しています。以前は、全てNAまたは空の Series / DataFrame に対する総和・総乗は NaN を返していました。詳細については、v0.22.0 whatsnewを参照してください。空あるいは全てがNAのSeriesまたはDataFrameの列の総和は0です。

In [**]: pd.Series([np.nan]).sum() Out[**]: 0.0 In [**]: pd.Series([], dtype="float64").sum() Out[**]: 0.0空あるいは全てがNAのSeriesまたはDataFrameの列の総乗は1です。

In [**]: pd.Series([np.nan]).prod() Out[**]: 1.0 In [**]: pd.Series([], dtype="float64").prod() Out[**]: 1.0GroupBy における欠損値

GroupByではNAグループは自動的に除外されます。この動作は、Rと一致しています。例えば、

In [**]: df Out[**]: one two three a NaN -0.282863 -1.509059 c NaN 1.212112 -0.173215 e 0.119209 -1.044236 -0.861849 f -2.104569 -0.494929 1.071804 h NaN -0.706771 -1.039575 In [**]: df.groupby('one').mean() Out[**]: two three one -2.104569 -0.494929 1.071804 0.119209 -1.044236 -0.861849詳細については、こちらのgroupbyセクションをご覧ください。

欠損データの除外・穴埋め

pandasオブジェクトには、欠損データを処理するためのさまざまなデータ操作メソッドが装備されています。

欠損値の穴埋め――fillna

fillna()は、欠損値を非欠損データで「穴埋め」することができます。欠損値をスカラー値に置換

In [**]: df2 Out[**]: one two three four five timestamp a NaN -0.282863 -1.509059 bar True NaT c NaN 1.212112 -0.173215 bar False NaT e 0.119209 -1.044236 -0.861849 bar True 2012-01-01 f -2.104569 -0.494929 1.071804 bar False 2012-01-01 h NaN -0.706771 -1.039575 bar True NaT In [**]: df2.fillna(0) Out[**]: one two three four five timestamp a 0.000000 -0.282863 -1.509059 bar True 0 c 0.000000 1.212112 -0.173215 bar False 0 e 0.119209 -1.044236 -0.861849 bar True 2012-01-01 00:00:00 f -2.104569 -0.494929 1.071804 bar False 2012-01-01 00:00:00 h 0.000000 -0.706771 -1.039575 bar True 0 In [**]: df2['one'].fillna('missing') Out[**]: a missing c missing e 0.119209 f -2.10457 h missing Name: one, dtype: object前方または後方のデータによる穴埋め

リインデックスと同様の穴埋めパラメータを使用して、非欠損値を前方または後方に伝播させることができます。

In [**]: df Out[**]: one two three a NaN -0.282863 -1.509059 c NaN 1.212112 -0.173215 e 0.119209 -1.044236 -0.861849 f -2.104569 -0.494929 1.071804 h NaN -0.706771 -1.039575 In [**]: df.fillna(method='pad') Out[**]: one two three a NaN -0.282863 -1.509059 c NaN 1.212112 -0.173215 e 0.119209 -1.044236 -0.861849 f -2.104569 -0.494929 1.071804 h -2.104569 -0.706771 -1.039575穴埋め量の制限

連続したギャップを一定のデータポイントまで埋めるだけの場合は、limitキーワードを使用できます。

In [**]: df Out[**]: one two three a NaN -0.282863 -1.509059 c NaN 1.212112 -0.173215 e NaN NaN NaN f NaN NaN NaN h NaN -0.706771 -1.039575 In [**]: df.fillna(method='pad', limit=1) Out[**]: one two three a NaN -0.282863 -1.509059 c NaN 1.212112 -0.173215 e NaN 1.212112 -0.173215 f NaN NaN NaN h NaN -0.706771 -1.039575利用可能な穴埋め方法は以下のとおりです。

メソッド 動作 pad / ffill 前方へ穴埋め bfill / backfill 後方へ穴埋め 時系列データでは、pad/ffill の使用は非常に一般的であるため、「最後の既知の値」がすべての時点で利用できるようになっています。

ffill()はfillna(method='ffill')と同等であり、bfill()はfillna(method='bfill')と同等です。pandas オブジェクトによる穴埋め

整列可能な辞書またはシリーズを使用して穴埋めすることもできます。辞書のキーあるいはシリーズのインデックスは、穴埋めしたいフレームの列名と一致する必要があります。以下の例は、データフレームにその列の平均を入力しています。

In [**]: dff = pd.DataFrame(np.random.randn(10, 3), columns=list('ABC')) In [**]: dff.iloc[3:5, 0] = np.nan In [**]: dff.iloc[4:6, 1] = np.nan In [**]: dff.iloc[5:8, 2] = np.nan In [**]: dff Out[**]: A B C 0 0.271860 -0.424972 0.567020 1 0.276232 -1.087401 -0.673690 2 0.113648 -1.478427 0.524988 3 NaN 0.577046 -1.715002 4 NaN NaN -1.157892 5 -1.344312 NaN NaN 6 -0.109050 1.643563 NaN 7 0.357021 -0.674600 NaN 8 -0.968914 -1.294524 0.413738 9 0.276662 -0.472035 -0.013960 In [**]: dff.fillna(dff.mean()) Out[**]: A B C 0 0.271860 -0.424972 0.567020 1 0.276232 -1.087401 -0.673690 2 0.113648 -1.478427 0.524988 3 -0.140857 0.577046 -1.715002 4 -0.140857 -0.401419 -1.157892 5 -1.344312 -0.401419 -0.293543 6 -0.109050 1.643563 -0.293543 7 0.357021 -0.674600 -0.293543 8 -0.968914 -1.294524 0.413738 9 0.276662 -0.472035 -0.013960 In [**]: dff.fillna(dff.mean()['B':'C']) Out[**]: A B C 0 0.271860 -0.424972 0.567020 1 0.276232 -1.087401 -0.673690 2 0.113648 -1.478427 0.524988 3 NaN 0.577046 -1.715002 4 NaN -0.401419 -1.157892 5 -1.344312 -0.401419 -0.293543 6 -0.109050 1.643563 -0.293543 7 0.357021 -0.674600 -0.293543 8 -0.968914 -1.294524 0.413738 9 0.276662 -0.472035 -0.013960上記と同じ結果ですが、以下の場合はシリーズである「穴埋め」の値を揃えています。

In [**]: dff.where(pd.notna(dff), dff.mean(), axis='columns') Out[**]: A B C 0 0.271860 -0.424972 0.567020 1 0.276232 -1.087401 -0.673690 2 0.113648 -1.478427 0.524988 3 -0.140857 0.577046 -1.715002 4 -0.140857 -0.401419 -1.157892 5 -1.344312 -0.401419 -0.293543 6 -0.109050 1.643563 -0.293543 7 0.357021 -0.674600 -0.293543 8 -0.968914 -1.294524 0.413738 9 0.276662 -0.472035 -0.013960データが欠損している軸ラベルの削除――dropna

単純に、欠損データを参照しているラベルをデータセットから除外したい場合もあるでしょう。これを行うには、

dropna()を使用します。In [**]: df Out[**]: one two three a NaN -0.282863 -1.509059 c NaN 1.212112 -0.173215 e NaN 0.000000 0.000000 f NaN 0.000000 0.000000 h NaN -0.706771 -1.039575 In [**]: df.dropna(axis=0) Out[**]: Empty DataFrame Columns: [one, two, three] Index: [] In [**]: df.dropna(axis=1) Out[**]: two three a -0.282863 -1.509059 c 1.212112 -0.173215 e 0.000000 0.000000 f 0.000000 0.000000 h -0.706771 -1.039575 In [**]: df['one'].dropna() Out[**]: Series([], Name: one, dtype: float64)シリーズにも同等の

dropna()が用意されています。DataFrame.dropna には Series.dropna よりもかなり多くのオプションがあり、APIで調べることができます。補間

バージョン 0.23.0 から:キーワード引数

limit_areaが追加されました。シリーズオブジェクトとデータフレームオブジェクトの両方に

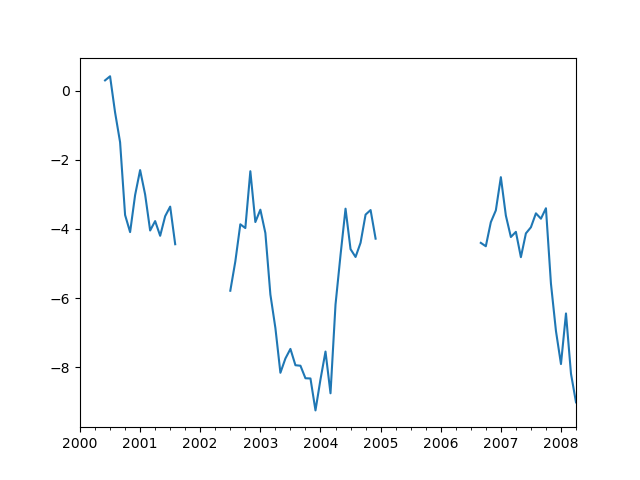

interpolate()があり、デフォルトでは、欠落しているデータポイントで線形補間を実行します。In [**]: ts Out[**]: 2000-01-31 0.469112 2000-02-29 NaN 2000-03-31 NaN 2000-04-28 NaN 2000-05-31 NaN ... 2007-12-31 -6.950267 2008-01-31 -7.904475 2008-02-29 -6.441779 2008-03-31 -8.184940 2008-04-30 -9.011531 Freq: BM, Length: 100, dtype: float64 In [**]: ts.count() Out[**]: 66 In [**]: ts.plot() Out[**]: <matplotlib.axes._subplots.AxesSubplot at 0x7fc18e5ac400>In [**]: ts.interpolate() Out[**]: 2000-01-31 0.469112 2000-02-29 0.434469 2000-03-31 0.399826 2000-04-28 0.365184 2000-05-31 0.330541 ... 2007-12-31 -6.950267 2008-01-31 -7.904475 2008-02-29 -6.441779 2008-03-31 -8.184940 2008-04-30 -9.011531 Freq: BM, Length: 100, dtype: float64 In [**]: ts.interpolate().count() Out[**]: 100 In [**]: ts.interpolate().plot() Out[**]: <matplotlib.axes._subplots.AxesSubplot at 0x7fc18e569880>

methodキーワードを用いることで、インデックスに基づいた補間を実行できます。In [**]: ts2 Out[**]: 2000-01-31 0.469112 2000-02-29 NaN 2002-07-31 -5.785037 2005-01-31 NaN 2008-04-30 -9.011531 dtype: float64 In [**]: ts2.interpolate() Out[**]: 2000-01-31 0.469112 2000-02-29 -2.657962 2002-07-31 -5.785037 2005-01-31 -7.398284 2008-04-30 -9.011531 dtype: float64 In [**]: ts2.interpolate(method='time') Out[**]: 2000-01-31 0.469112 2000-02-29 0.270241 2002-07-31 -5.785037 2005-01-31 -7.190866 2008-04-30 -9.011531 dtype: float64浮動小数点インデックスの場合、

method='values'を使用します。In [**]: ser Out[**]: 0.0 0.0 1.0 NaN 10.0 10.0 dtype: float64 In [**]: ser.interpolate() Out[**]: 0.0 0.0 1.0 5.0 10.0 10.0 dtype: float64 In [**]: ser.interpolate(method='values') Out[**]: 0.0 0.0 1.0 1.0 10.0 10.0 dtype: float64同様に、データフレームを補間することができます。

In [**]: df = pd.DataFrame({'A': [1, 2.1, np.nan, 4.7, 5.6, 6.8], ....: 'B': [.25, np.nan, np.nan, 4, 12.2, 14.4]}) ....: In [**]: df Out[**]: A B 0 1.0 0.25 1 2.1 NaN 2 NaN NaN 3 4.7 4.00 4 5.6 12.20 5 6.8 14.40 In [**]: df.interpolate() Out[**]: A B 0 1.0 0.25 1 2.1 1.50 2 3.4 2.75 3 4.7 4.00 4 5.6 12.20 5 6.8 14.40

method引数を用いることで、より高度な補間を実行することができます。scipyがインストールされている場合は、一次元補間ルーチンの名前をmethodに渡すことができます。詳細については、scipyの補間に関するドキュメントやリファレンスガイドを参照してください。適切な補間方法は、扱うデータの種類によって異なります。

- 増加率の高い時系列を扱う場合は、

method='quadratic'が適切かもしれません。- 累積分布関数に近似した値の場合は、

method='pchip'がうまく機能するはずです。- スムーズなプロットを目指して欠損値を埋めるには、

method='akima'を検討してください。

警告

これらのメソッドにはscipyが必要です。In [**]: df.interpolate(method='barycentric') Out[**]: A B 0 1.00 0.250 1 2.10 -7.660 2 3.53 -4.515 3 4.70 4.000 4 5.60 12.200 5 6.80 14.400 In [**]: df.interpolate(method='pchip') Out[**]: A B 0 1.00000 0.250000 1 2.10000 0.672808 2 3.43454 1.928950 3 4.70000 4.000000 4 5.60000 12.200000 5 6.80000 14.400000 In [**]: df.interpolate(method='akima') Out[**]: A B 0 1.000000 0.250000 1 2.100000 -0.873316 2 3.406667 0.320034 3 4.700000 4.000000 4 5.600000 12.200000 5 6.800000 14.400000多項式またはスプライン近似で補間する場合は、近似の次数も指定する必要があります。

In [**]: df.interpolate(method='spline', order=2) Out[**]: A B 0 1.000000 0.250000 1 2.100000 -0.428598 2 3.404545 1.206900 3 4.700000 4.000000 4 5.600000 12.200000 5 6.800000 14.400000 In [**]: df.interpolate(method='polynomial', order=2) Out[**]: A B 0 1.000000 0.250000 1 2.100000 -2.703846 2 3.451351 -1.453846 3 4.700000 4.000000 4 5.600000 12.200000 5 6.800000 14.400000いくつかの方法を比較してみましょう。

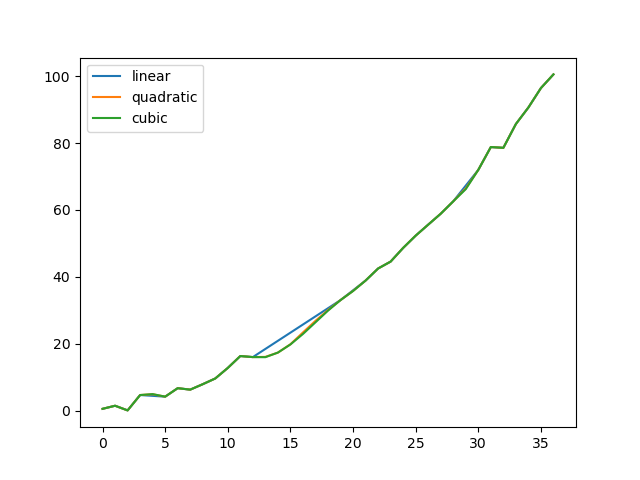

In [**]: np.random.seed(2) In [**]: ser = pd.Series(np.arange(1, 10.1, .25) ** 2 + np.random.randn(37)) In [**]: missing = np.array([4, 13, 14, 15, 16, 17, 18, 20, 29]) In [**]: ser[missing] = np.nan In [**]: methods = ['linear', 'quadratic', 'cubic'] In [**]: df = pd.DataFrame({m: ser.interpolate(method=m) for m in methods}) In [**]: df.plot() Out[**]: <matplotlib.axes._subplots.AxesSubplot at 0x7fc18e5b6c70>もうひとつの使用例は、新しい値での補間です。ある分布から100個の観測値があるとします。そして、中央付近で何が起こっているかに特に興味があるとしましょう。pandasの

reindexとinterpolateメソッドを組み合わせることで、新しい値で補間することができます。In [**]: ser = pd.Series(np.sort(np.random.uniform(size=100))) # 新しいインデックスに対する補間 In [**]: new_index = ser.index | pd.Index([49.25, 49.5, 49.75, 50.25, 50.5, 50.75]) In [**]: interp_s = ser.reindex(new_index).interpolate(method='pchip') In [**]: interp_s[49:51] Out[**]: 49.00 0.471410 49.25 0.476841 49.50 0.481780 49.75 0.485998 50.00 0.489266 50.25 0.491814 50.50 0.493995 50.75 0.495763 51.00 0.497074 dtype: float64補間の制限

pandasの他の穴埋めメソッドと同様に、

interpolate()はキーワード引数limitを受け取ります。この引数を使用して、最後の有効な観測以降に入力された連続したNaN値の数を制限できます。In [**]: ser = pd.Series([np.nan, np.nan, 5, np.nan, np.nan, ....: np.nan, 13, np.nan, np.nan]) ....: In [**]: ser Out[**]: 0 NaN 1 NaN 2 5.0 3 NaN 4 NaN 5 NaN 6 13.0 7 NaN 8 NaN dtype: float64 # 前方へ連続するすべての値を埋める In [**]: ser.interpolate() Out[**]: 0 NaN 1 NaN 2 5.0 3 7.0 4 9.0 5 11.0 6 13.0 7 13.0 8 13.0 dtype: float64 # 前方へ1つだけ値を埋める In [**]: ser.interpolate(limit=1) Out[**]: 0 NaN 1 NaN 2 5.0 3 7.0 4 NaN 5 NaN 6 13.0 7 13.0 8 NaN dtype: float64デフォルトでは、

NaN値は順方向に穴埋めされます。後方または両方向から穴埋めするには、limit_directionパラメータを使用します。# 後方へ1つ穴埋め In [**]: ser.interpolate(limit=1, limit_direction='backward') Out[**]: 0 NaN 1 5.0 2 5.0 3 NaN 4 NaN 5 11.0 6 13.0 7 NaN 8 NaN dtype: float64 # 両方向へ1つ穴埋め In [**]: ser.interpolate(limit=1, limit_direction='both') Out[**]: 0 NaN 1 5.0 2 5.0 3 7.0 4 NaN 5 11.0 6 13.0 7 13.0 8 NaN dtype: float64 # 両方向に連続するすべての値を埋める In [**]: ser.interpolate(limit_direction='both') Out[**]: 0 5.0 1 5.0 2 5.0 3 7.0 4 9.0 5 11.0 6 13.0 7 13.0 8 13.0 dtype: float64デフォルトでは、