- 投稿日:2020-05-26T22:07:59+09:00

Dockerで不要なイメージやコンテナを一括削除する方法

- 投稿日:2020-05-26T21:59:50+09:00

DockerコンテナをもとにDockerイメージを作成に関するコマンドまとめ

Dockerコンテナは、Dockerイメージをもとに作成することもできます。

公式のイメージをもとに、コンテナを作成、環境に合うように設定変更したコンテナから再度イメージ作成することも、、。

コンテナからイメージ作成

$ docker container commit [オプション] コンテナ識別子 [イメージ名[:タグ名]]

オプション 説明 --author, -a 作成者を指定する --message, -m メッセージを指定する --change, -c コミット時のDockerfile命令指定 --pause,-p コンテナを一時停止してコミットする コンテナをtarファイル出力

$ docker container export コンテナ識別子Dockerでは、動作しているコンテナのディレクトリ/ファイル群をまとめてtarファイルを作成することができます。

このtarファイルをもとにして、別のサーバでコンテナを稼働させることができます。

tarファイルからイメージ作成

$ docker container import ファイルまたはURL - [イメージ名[: タグ名]]

- tar

- tar.gz

- tgz

- bzip

- tar.xz

- txz

ファイルであれば指定可能

イメージの保存

$ docker image save [オプション] 保存ファイル名 [イメージ名]Dockerイメージをtarファイルに保存することができます。

-o オプションで、保存するファイル名を指定できます。イメージの読み込み

$ docker image load [オプション]-iオプションで、読み込みファイル名を指定できます。

- 投稿日:2020-05-26T21:39:51+09:00

稼働中のDockerコンテナの操作コマンドのまとめ

本番で運用するときには、稼働中のDockerコンテナに対して操作をします。

その時に使えるコマンドをまとめます。

稼働コンテナへの接続

$ docker container attach コンテナ識別子終了させる時は、Ctr+PかCtr+Qキーを入力します。

稼働コンテナへのプロセス実行

$ docker container exec [オプション] コンテナ識別子 実行するコマンド [引数]

オプション 説明 --detach, -d コマンドをバッググラウンドで実行する --interactive, -i コンテナの標準入力を開く --tty, -t false --user, -u ユーザ名指定 docker container execコマンドは、起動中のコンテナにのみ実行できます。

停止中のコンテナは、docker container start コマンドを使ってコンテナを起動します。稼働コンテナへのプロセス確認

$ docker container top コンテナ識別子実行しているプロセスのPIDとUSERと実行しているコマンドが表示されます。

稼働コンテナのポート転送確認

$ docker container port コンテナ識別子コンテナの名前変更

$ docker container rename名前変更できたかを確認するには、

bash

$ docker container ls

をします。コンテナ内のファイルをコピー

$ docker container cp コンテナ識別子:コンテナ内のファイルパス ホストのディレクトリパス$ docker container cp ホストのファイル コンテナ識別子:コンテナ内のファイルパスコンテナ操作の差分確認

$ docker container diff コンテナ識別子変更の区分

区分 説明 A ファイル追加 D ファイル削除 C ファイル更新

- 投稿日:2020-05-26T21:19:54+09:00

Dockerコンテナのネットワーク操作コマンドまとめ

Dockerコンテナ同士が通信するとき、Dockerネットワーク経由してます。

そのDcokerコンテナのネットワーク操作コマンドをまとめました。

ネットワークの一覧表示

$ docker network ls [オプション]

オプション 説明 --filter=[], -f 出力をフィルタする --no-trunc 詳細を出力する --quiet, -q ネットワークIDのみを表示する Dockerはデフォルトでbridge/host/noneの3つのネットワークを作成します。

filterで利用できるキー

項目 説明 driver ドライバーの指定 id ネットワークID label ネットワークに設定されたラベル name ネットワーク名 scope ネットワークのスコープ type ネットワークのタイプ ネットワークの作成

$ docker network create [オプション] ネットワーク

オプション 説明 --driver, -d ネットワークブリッジまたはオーバレイ(デフォルトはbrige) --ip-range コンテナに割り当てるIPアドレスのレンジを指定 --subnet サブネットをCIDR形式で指定 --ipv6 IPv6ネットワークを有効にするかどうか -label ネットワークに設定するラベル ネットワークへの接続

$ docker network connect [オプション] ネットワーク コンテナ

オプション 説明 --ip IPv4アドレス --ip6 IPv6アドレス --alias エイリアス名 --link 他のコンテナへのリンク ネットワークからの切断

$ docker network disconnect [オプション] ネットワーク コンテナネットワークの詳細確認

$ docker network inspect [オプション] ネットワークネットワークの削除

$ docker network rm [オプション] ネットワーク

- 投稿日:2020-05-26T21:02:35+09:00

Macのdockerが遅いストレスから解放されよう

Mackのdocker遅い問題

Macで開発している時、主にRailsなのですがdockerを使うと遅くなるのが嫌でずっと避けてましたが、とあるプロジェクトでBFF構成にし開発環境とデプロイ環境をECS化したりとでdocker化の流れに抗えない状況になりました。

ただ、やはり遅い。

dockerが不慣れなこともありますが、Macのdockerなかなか遅い。

そしてMacが遅い件を調べてみてもみなさん困られるのが伺えます。

そんな中で対策としてよく見かけるのが

- docker-sync

- vagrantで別立て

の2つでした。

どちらが最適なのかな?と思い悩んでると、

ありました。dockerのドキュメントにまさにこの件に対しての内容が。

https://docs.docker.com/docker-for-mac/osxfs-caching/

ボリュームマウントのチューニング

端的にまとめるとv17.04から

cachedとdelegatedというオプションが追加され、書き込み読み込みの一貫性を担保しない(※)代わりにパフォーマンスが向上されるものです。※コンテナ側で発生した変更がホスト側に書き込みされるまで遅延を許容する。

即時性を求められたり大規模な処理を組むこともなく、開発環境だけで使うことから現状大きな支障はないと思いこちらのオプションを利用することにしました。

導入の仕方

- volumesの指定の最後に

:delegatedをつけていつも通りdocker-compose upを実行例services: app: volumes: - .:/project/sample_app:delegatedtips

linuxやwindowsユーザーの方と一緒に開発する場合は必要ないかと思うので、そんな時は通常使う

docker-compose.ymlに基本的な設定そのままにdocker-compose-local.ymlのように、別ファイル名のymlを用意します。そこに例のように

services:、サービス名:、vpluems:、マウント先:に:delegateオプションを追加したものをのみを残しdocker-compose -f docker-compose.yml -f docker-compose-local.yml upとオプション指定すればvolumesの指定のみ上書かれるのでMacユーザーの方はこちらを利用したら住み分けできて便利です。

※docker-compose.ymlにversion指定されていたら、versionの指定は合わせます。

改善の結果

ただのindexのレコード取得でも数秒、初回アクセスで10秒オーバーするケースがあったものが普通にサクサクと動くようになりました。

プロジェクトの内容や要件に合わせてですが、遅すぎてストレスが激しくdocker嫌いになる前に是非試してみてください。

まず困ったら公式ドキュメントをしっかり読むことの大事さを改めて実感する一件でした。

- 投稿日:2020-05-26T20:50:36+09:00

Windows10上のVirtualBoxで稼働するUbuntuにDockerをインストール

概要

Ubuntuで、pythonを実行できる環境を整備したいが、pythonは頻繁にバージョンアップするし、プログラムの目的ごとにpipで追加したいパッケージのバージョンが異なったりする。

venv(または、pyenv等)で切り替えることも検討したが、もういっそコンテナの方が便利かも・・・

ということで、Windows10上のVertualBoxで稼働するUbuntuにDockerをインストールする手順・・・基本的には、以下に記載の手順通り。

「Install Docker Engine on Ubuntu」

https://docs.docker.com/engine/install/ubuntu/Windows10のVirtualBoxインストール手順はこちら

VirtualBoxVirtualBoxにUbuntuをインストールする手順はこちら

Ubuntu前準備

既存Dockerの確認

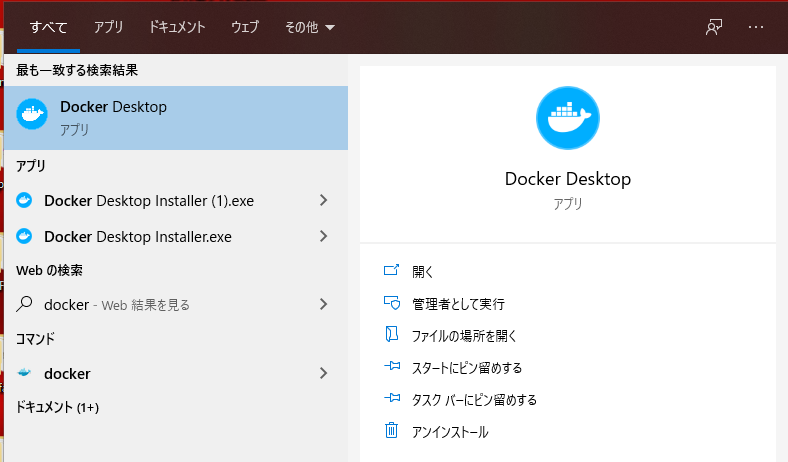

Ubuntuにログイン。

[アクティビティ]-[アプリケーションを表示する]を選択。

[端末]を起動し、以下のコマンドを実行し、Dockerがinstallされていないことを確認する。apt list --installed | grep dockerもしインストールされていたら、先に削除しておくことをお勧め。

sudo apt remove docker docker-engine docker.io containerd runcDockerフォルダの確認

以下のコマンドを実行し、旧バージョンの残骸がないことを確認する。

ls /var/libもし存在していたら、削除しておく。

sudo rm -rf /var/lib/dockerリポジトリの設定

必要なコマンドの追加

以下のコマンドを実行し、リポジトリ追加のために必要なコマンドがインストールされているか確認する。

apt list --installed | grep apt-transport-https apt list --installed | grep ca-certificates apt list --installed | grep curl apt list --installed | grep gnupg-agent apt list --installed | grep software-properties-common

上記の結果を確認し、インストールされていないものをインストール。

(例では、ca-certificates、software-properties-commonはインストールされているのでインストール不要。)sudo apt install apt-transport-https sudo apt install ca-certificates sudo apt install curl sudo apt install gnupg-agent sudo apt install software-properties-commonapt-keyの設定

以下のコマンドを実行。

curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo apt-key add -確認

sudo apt-key fingerprint 0EBFCD88リポジトリ追加

sudo add-apt-repository "deb [arch=amd64] https://download.docker.com/linux/ubuntu $(lsb_release -cs) stable"インストール

以下のコマンドを実行。

sudo apt install docker-ce

途中確認ダイアログが表示されたら、yを入力し、[Enter]キーを押下。

インストール終了。動作確認

以下のコマンドを実行。

sudo docker version以下のコマンドを実行。

sudo docker run hello-worldDocker実行権限の追加

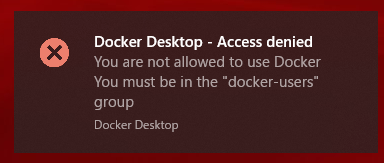

一般ユーザエラー

デフォルトの状態では、rootユーザしかdockerを使用できない。

権限追加

一般ユーザでdockerを使用するためには、以下の権限追加が必要。

sudo usermod -a -G docker (権限追加するユーザ)反映させるためには、再起動。

(systmctl restart dockerを実行し、当該ユーザのターミナルを再接続してもOK。)sudo reboot動作確認

以下のコマンドを実行。

docker run hello-world参考

- 投稿日:2020-05-26T20:49:45+09:00

Qiitaはじめました。

概要

4月から新社会人になった駆け出しエンジニアです。

研修も全面リモートワークということもあり、何かはじめてみようと思い、自分がやってみた(やらなきゃいけない)ことをQiitaにアウトプットしていくことにしました。初投稿は自分のモチベーションのために、技術的な内容ではなく、これからやってみたいこととか書いていければと思います。

これから何するの?

やっていきたいことは多々あるんですけど、なかでもバックエンドにフォーカスしていければと思います。(とか言いながら最近はVueに挑戦している)

と言うのも、就活をしていたときぐらいから何となくバックエンドの技術に興味があり、ちょっと調べているうちにやってみたいと思うようになったからで。

また、会社の配属先の部署で自動化やネットワークプログラマビリティなどのような高度な技術が必要とのことで、そこらへんに関連するバックエンドを中心に勉強していけたらと思っております。

具体的には?

具体的に取り組んでみたい内容を簡単に書き出してみました。

・Ruby on Rails(Javaの復習がてら)

・AWSのLambdaとかGreengrassとラズパイ

・Dockerでコンテナ型の仮想化を理解

・Kubernetes(ムズい)

などなど。。。挙げだしたらキリがないです。。。

若干独学で出来るのか不安なところはありますが、会社に詳しい人がいると思うので、色々手を動かしながらやっていきたいです。おい、資格の勉強はどうした?

資格て応用情報のことですよね。結論としては多分受けないです。

その代わり(?)といっては何ですが、今年から始まったCiscoのDevNet認定に今興味があり、色々調べています。というのも、カリカリ勉強するよりパチパチコード書いてアウトプットしていったほうが圧倒的にスキルになるなと最近感じ始めたからで。

DevNet認定ではネットワークの基礎知識だけではなく、冒頭に申し上げたネットワークプログラマビリティや自動化が範囲としてあり、Python/Git/APIなどの幅広いモダンな開発知識が求められます。

個人的にIoT/IoEやDevOpsに興味があるので、ピッタリな内容かなと思いました。お前、英語のこと忘れてるだろ

はい、最近気付きました。

チリツモを信じて毎朝Duoのチャプターひとつやるようにしてます。。。頑張ります。。。最後に一言

これから長い長いエンジニア人生がはじまりますが、クリエイティブな思考を忘れないようにしたいものです。

ということで、これから触ってみた技術や知見をQiitaに書き留めていきたいと思います。

はじめはクオリティ低いと思いますが、よろしくお願いします。

- 投稿日:2020-05-26T20:11:00+09:00

システム日時を変更してcurlで証明書検証エラーが出たら--insecureをつける

タイトルの通りです。結論はこちら

問題が発生した状況

PHPUnitを利用して、以下のようにexec()でテスト対象のAPIを叩くという内容のテストを作成していました。(デバッグ用のオプションは省略->こちらが参考になります)

curl -X POST https://[テスト対象APIのURL] -d [POSTするデータ] > [出力先ファイル]そのテストにおいて、システム日時を変更する必要があったので、

date -s "2020-01-01 00:00:00"とコマンドを実行してコンテナ内のシステム日時を変更する処理を追加しました。

すると、以下のようなエラーが出ました。curl: (60) Peer certificate cannot be authenticated with known CA certificates More details here: http://curl.haxx.se/docs/sslcerts.htmlcurl performs SSL certificate verification by default, using a "bundle" of Certificate Authority (CA) public keys (CA certs). If the default bundle file isn't adequate, you can specify an alternate file using the --cacert option. If this HTTPS server uses a certificate signed by a CA represented in the bundle, the certificate verification probably failed due to a problem with the certificate (it might be expired, or the name might not match the domain name in the URL). If you'd like to turn off curl's verification of the certificate, use the -k (or --insecure) option.証明書が認証されていないから、検証がいらないなら飛ばしたほうがいいよ、というようなことが書いてあります。

どうやって解決したか

テストコードなので証明書検証をスキップしました。

上記のエラーメッセージに従って --insecure のオプションをつけます。curl -X POST https://[テスト対象APIのURL] -d [POSTするデータ] --insecure > [出力先ファイル]これで証明書を検証せずにテストコードを走らせることができました。

まとめ

システム日時を変更することで、証明書検証が通らなくなることがあるみたいです。

今回はテストコードだったので証明書検証をスキップできましたが、本番環境だったら、日時の変更も考慮に入れて証明書を用意しないといけませんね。まあ、本番環境でそうそう日時変えないと思いますが。。。

- 投稿日:2020-05-26T19:33:12+09:00

Docker コンテナ内で何をやっても Permission denied と言われた時の対処法

急にコンテナが牙をむいた

何がきっかけか分からないが、

sudo docker-compose run コンテナ名 bash

で、bashに入ると、入れるには入れるが 「.bashrc なんとかかんとか Permission denied」というエラーがついてきた。その後、コンテナ内でプログラムをコンパイルしようとすると、こちらもPermission denied。pythonを動かそうとしてもPermission denied。ことごとく何もできなくなってしまった。

挙句の果てに

rootなのに

sudoさせてもらえなくなってしまった。root権限とはいったい...コンテナ側が悪いのか、ホスト側が悪いのか

まずは、コンテナ側の権限周りがおかしいと考えた。

sudoersの権限を確認したりと、いろいろ試したがどうにも原因らしきものが見つからない。仕方がないので、コンテナを組みなおしてみる

sudo docker-compose build --no-cacheっと...

こ こ で も か Permission denied

解決

https://stackoverflow.com/questions/59633611/docker-permission-denied-on-login-and-everything-i-try

色々調べると、このような記事が出てきた。

sudo apt install docker.io

をして、再度buildを回してみる。buildが始まった!

動いた!

困ったことに

困ったことに、このようになったトリガーが今一つ分かっていない。

ubuntuのアップデート?

一つ心当たりがあるのは、Dockerfileを変更後、--no-chacheをせずにdocker-composeしてしまったこと。

原因をご存じの方は、教えていただけると幸いです。

- 投稿日:2020-05-26T18:05:29+09:00

目で見て覚えるDocker用語集

いつまでたってもKubernetesの正しい読み方が分からない今日この頃です。

概要

- 簡単なDocker入門記事です。

- Dockerの書籍を読む前に見てもらえればいいな、ぐらいのニュアンスで作られてます。

- 文章少なめ、イメージ図多めです。

- そんなに深い話はしません。

ターゲット

- これからDockerを触ってみようという人

- Docker触ってるけど用語が多すぎて頭がパンクしそうな人

Dockerとは

- Docker社が開発している、コンテナ型の仮想環境を作成、配布、実行するためのプラットフォームです。

コンテナって何

- コンピュータの仮想化の方式の一つです。

- 従来の仮想化と違い、ゲストOSを用意しません。

- ホストOSの一部を分離して使用し、他と隔離された専用のエリアを用意します。

- 隔離された領域のことをコンテナといいます。

コンテナだと何がいいの?

- 既存の仮想化を二世帯住宅やマンションに例えると、コンテナ型仮想環境はキャンプ場に近いです。

- キャンプ場はコンテナ技術が搭載されているサーバで、キャンプ場に設置されたテント一つ一つがコンテナです。

- テントはキャンプ場のルール(サーバスペック)さえ守れば、大きさ・場所含めて自由に設置ができます。

- 家とは違い、トイレや水道などの共同箇所(OS)は各テント共同で使用しなければいけません。

- 共同箇所の変更はキャンプ場のオーナーしかできません。

- トイレや水道をテント内に設置しなくてすむので、設置に時間がかかりません。

- テントはキャンプが終わり次第片付けるので、場所(リソース)の再利用が容易です。

用語集

Dockerエンジン

エンジンとは、一般的には内燃機関を指すが、IT用語としては、ある特定の処理を行うための機能を提供する、ひとまとまりになった処理装置のことである。プログラムを指す場合が多いが、カスタムICなどのハードウェアを指す場合もある。

出典:https://www.sophia-it.com/content/%E3%82%A8%E3%83%B3%E3%82%B8%E3%83%B3コンテナ型仮想化技術(機能)を提供するプログラムを指します。

Dockerホスト

Dockerエンジンが動作しているサーバを指します。

Docker社公式アイコンのクジラ部分(赤枠)が該当します。Dockerコンテナ

Dockerエンジンによって提供されたコンテナ型仮想環境を指します。

Docker社公式アイコンのコンテナ部分(赤枠)が該当します。

Dockerホスト上に複数のコンテナを搭載することができます。Dockerイメージ

Dockerコンテナ構成をまとめたもの(テンプレート)を指します。

Dockerイメージを元にDockerコンテナを作成します。

Dockerイメージは使い回しができるので複数コンテナをまとめて作成できます。

別のDockerホストに同じDockerコンテナを作成することもできます。Dockerfile

Dockerfileは、Dockerイメージを自動で作成してくれるファイルを指します。

基本となるイメージを設定することができます。

追加で入れたいアプリや環境変数・コマンドなどを設定できます。docker image build

Dockerfileを元にDockerイメージを作成することを指します。

作成されたDockerイメージを元にDockerコンテナを作成します。

作成されたDockerイメージは後述のDocker Registryに登録・管理することもできます。Docker Repository

ソフトウェア開発などに用いるプロジェクト管理システムやバージョン管理システムなどで、プロジェクトを構成するプログラムのソースコードやドキュメント、関連する各種のデータやファイルなどを一元的に管理する格納場所のことをリポジトリという。

出典:http://e-words.jp/w/%E3%83%AA%E3%83%9D%E3%82%B8%E3%83%88%E3%83%AA.html同名のDockerイメージの集まりを指します。

差分管理やバージョン管理をタグをつけることで区分けしています。Docker Registry

Dockerイメージを持つDocker Repositryを保管・管理するサービスを指します。

publicなもの(Docker Hub etc)とprivateなものの2種類があります。

privateなものについては、Docker上で別途Docker Registry専用のコンテナを構築する必要があります。Docker Hub

Docker Registryの1種でコンテナ共有サービスを指します。

作成したDocker Repositryをアップすることで、Git Hubのような配布・変更管理などの機能を提供します。Data Volume

Dockerコンテナ内のディレクトリをDockerホストのディスクに永続化する仕組みを指します。

上記を使用することで、Dockerホスト・コンテナ間でのディレクトリの共有・再利用ができます。

ステートフルなアプリケーションをコンテナで実現する際に使用されます。Data Volume コンテナ

コンテナ間でディレクトリを共有する仕組みを指します。

Data Volume用のコンテナを用意し、他のコンテナは全てData Volume用のコンテナを参照します。

仲介役のコンテナがあるため、アプリケーション用コンテナはDockerホスト側の情報を知る必要がありません。Docker Compose

複数コンテナを構築・実行する手順の自動化・管理を容易にするツールを指します。

複数のコンテナを使って1つのアプリケーションを構築する場合などに使用します。(例)master - slave etcdocker-compose.yml

複数コンテナの構築・実行手順をまとめたファイルを指します。

構築したいコンテナのイメージ(or Dockerfile)が定義されています。

他にも起動順・条件やコンテナ間の接続情報なども定義することができます。Docker Swarm

複数のDockerホストを束ねてクラスタ化するツールを指します。(ロゴも大勢のクジラでコンテナを運んでいます)

Docker Swarmを使ってクラスタ化されたクラスタをSwarm Clusterといいます。

Docker Swarmはコンテナオーケストレーションシステムの1つです。オーケストレーションとは、複数の統合されていないシステムにわたる多数のステップを含む

プロセスやワークフローを自動化する方法を指します。

出典:https://www.redhat.com/ja/topics/automation/what-is-orchestrationDocker Node

Swarm Clusterを構成するDockerホストのことを指します。

Docker Nodeには『manager』と『worker』の2種類があります。manager

Swarm Cluster内のDocker Nodeを管理するDocker Nodeを指します。

後述のworkerの機能も兼業することができます。

アイコンの黄枠で囲まれたクジラが該当します。(上に乗っているクジラの面倒を見ているイメージです)worker

コンテナを実行するDocker Nodeを指します。

アイコンの赤枠で囲まれたクジラが該当します。Service

アプリケーションを構成する一部のコンテナを制御するための単位を指します。(アイコンの赤枠が該当)

webアプリケーションを例にすると、Serviceは『web』と『API』の2つで構成することができます。Stack

複数のServiceをグルーピングした単位を指します。(アイコンの赤・黄・青枠がそれぞれ該当)

Stackはアプリケーション全体の構成を定義することができます。

Stackで利用するoverlayネットワークを設定しないと、Stackの数だけoverlayネットワークが作成されます。overlayネットワーク

コンテナ間通信が可能なネットワークのことを指します。

Stack作成時にデフォルトでネットワークが作成されます。

設定で別のoverlayネットワークに対象のStackを所属させることもできます。

同じoverlayネットワークに所属していれば、異なるStackのコンテナ間でも通信ができます。stack file

Stack内の情報をまとめたファイルを指します。

内容として、Service情報、Dockerイメージ、構築するコンテナ台数、所属するoverlayネットワーク情報があります。Kubernetes

Google社主導で開発されたコンテナオーケストレーションシステムです。

読みは「クバネティス/クバネテス/クーべネティス」、表記は「k8s」などがあります。

現在、主流のコンテナ管理ツールです。

機能としては、docker-composeやdocker swarmの機能を全て持っています。

さらにコンテナ間のネットワークルーティング管理等もできます。

公式アイコンにあるようコンテナ船の舵取りのような位置付けです。詳細は別途Kubernetesの用語集記事を作成予定です。

まとめ

- コンテナ技術はサーバ仮想化技術の一つです。

- コンテナ技術を提供するプログラムがDockerです。

- DockerコンテナはDockerイメージを元に構築されます。

- Dockerイメージを管理するツールがDocker Registry(Docker Hub)です。

- Docker Composeは複数のコンテナを管理・操作するツールです。

- Docker Swarmは複数のDockerホストを束ねクラスタ化するツールです。

- Docker ComposeやDocker Swarmの高機能版がKubernetesです。

おまけ

コンテナ技術も仮想化技術の一種なので、もちろんクラウドサービスの対象になります。

代表的なサービスを以下に紹介します。※AWS贔屓なのはAWSぐらいしかクラウドサービスを触ったことがないためです汗

代表的なコンテナクラウドサービス

AWS

ECS(EC2 Container Service)

AWS が開発したコンテナ管理サービスを指します。

コンテナの実行環境として、EC2・Fargateのどちらも選択できます。EKS(Elastic Container Serice for Kubernetes)

Kubernetesのマネージドサービス(コンテナ管理サービス)を指します

コンテナの実行環境として、EC2・Fargateのどちらも選択できるようになりました。Fargate

サーバレスのコンテナ可動サービスを指します。

コンテナを登録するだけでリソースを気にせずに利用することができます。

コンテナ単位に課金されます。Microsoft Azure

AKS(Azure Kubernetes Service)

KubernetesをAzureで動かすためのコンテナ可動サービスを指します。

ACR(Azure Container Registry)

コンテナのイメージ用に利用できるプライベートレジストリサービスを指します。

Google Cloud

GKE(Google Kubernetes Engine)

Kubernetesをベースとしたコンテナ管理サービスを指します。

Cloud Run

フルマネージド環境でステートレスコンテナを実行できるコンテナ可動サービスを指します。

サーバーレスなのでインフラストラクチャ管理が一切不要です。

コード実行時に課金されます。最後に

Dockerは用語の説明見るよりも、各ツールのアイコンを見た方がイメージしやすいです。

最近の技術というだけあって、アイコンにもユーザビリティが溢れている点はとてもいいですね。

- 投稿日:2020-05-26T16:14:37+09:00

multi stage build でpythonのC言語依存モジュールをインストールする

背景

alpineでC言語依存モジュールを pip install すると激重になる話

- alpineだと上記事象が避けられない

- multi stage buildで生成物を引っ張ってくるのが折衷案として良さそう

- 生成物を再利用する方法が安全ではない

- ベースイメージから生成物をベタに

COPYしている部分をやめる*.whlを持ってきて安全にインストールする方法を採ってみる- ついでに小手先技でimageを軽くしてみる

手順

- alpineイメージ上で必要モジュールをビルド

- 生成物(wheelファイル)は再利用しやすいように一箇所にまとめる

- ビルド完了済みイメージとして docker hub に push

- 実行環境用のalpineに multi stage build でwheelのディレクトリだけ取得しインストール

- 実行確認とお掃除

実装

まずは、必要なモジュール郡の取得から

今回は以下のモジュールを導入してみるrequirements.txtcycler==0.10.0 Cython==0.29.17 h5py==2.10.0 joblib==0.14.1 kiwisolver==1.2.0 matplotlib==3.2.1 numpy==1.18.4 pandas==1.0.3 Pillow==7.1.2 pyparsing==2.4.7 python-dateutil==2.8.1 pytz==2020.1 scikit-learn==0.22.2.post1 scipy==1.3.3 six==1.14.0必要モジュールを一箇所に集める

alpineの場合だとc言語依存モジュールはtarやzipなどの圧縮形式が落ちてくる。

これらをwhl形式に変換しておく必要がある。下準備

whlに変換時に必要なライブラリが存在するはずなので、apk経由でinstallしておく

apk update \ && apk add --virtual .build --no-cache openblas-dev lapack-dev freetype-dev ... && apk add --virtual .community_build --no-cache -X http://dl-cdn.alpinelinux.org/alpine/edge/community hdf5-dev必要なwhlファイルを用意する

pip downloadでもモジュールのダウンロードを実行できるが、

pip wheelコマンドだとダウンロードとtar/zipファイルを自動展開してビルドまで行ってくれるのでこちらを使用。

pip wheelも-rオプションを使用できるのでpip freeze > requirements.txtなどでバージョニングファイルを指定する。pip wheel --no-cache --wheel-dir=./whl -r requirements.txt

- オプション補足

--no-cache-dir: キャッシュを使用・作成をしない。指定しないと~/.tmpとかにもりもりキャッシュされる。ビルド時の生成物もキャッシュされる。--wheel-dir: wheelファイルのアウトプット先。pip wheelを使用する場合の補足

残念ながら今回の場合は途中で失敗する

別alpine環境で構築しpip freezeしたrequirements.txtを使用しているのだが、

numpy,scipyが使用できる環境でないためscikit-learnビルド中に落ちる。

pip install -r requirements.txtだとpip側がよしなにインストールしてくれるが1

今回に限っては先に依存モジュールを入れておくしか無い。2pip install cython numpy==1.18.4 scipy==1.3.3 pip wheel --no-cache --wheel-dir=./whl -r requirements.txtnumpyやscipyのビルドを回避するために別途イメージを作ろうとしていたのに

なんだか無意味なことをしている気がしてきたぞ...?ビルド完了後

docker hubにpush適当にタギングしてpush

docker tag 123456789a hoge/builder-image:latest docker push hoge/builder-image:latest実行環境用に生成物を持ってくる

ここからは実行環境用のdockerfile上で作業していく。

ローカルディレクトリのwheelをインストール

pip installで複数モジュールを指定するにはベタ書きしていくか--requirementでテキストファイルを指定する。

適当なディレクトリにwhlを集めて丸ごとインストールできるような仕様は無い。今回はマルチステージビルドでwheelが入ったディレクトリを

COPYし下記コマンドを実行することでローカルのwheelからインストールする。pip install --no-index --no-deps --no-cache-dir -f ./whl -r requirement.txt

- オプション補足

--no-index: PyPiのようなインデックスサイトを使わない。オンラインを経由したくない時に使う--no-deps: 依存モジュールをインストールしない。ただし、モジュール側で明確に指定されている場合はその限りでない模様。-f,--find-links: モジュールの検索先を指定。ローカルパスを指定したい時はこれを使う--upgrade で対応するモジュール

pipやsetuptoolsなど

--upgradeオプションをつけて導入したいモジュールはアップグレード用のテキストファイルに分けて導入する。

-rオプションで参照するテキストファイルはバージョン指定無しでもインストールは可能だ。upgrade.txtpip setuptools wheel下記コマンドで特定ディレクトリにまとめたモジュールをupgrade

pip install -U --no-index --no-deps --no-cache-dir -f ./upgrade -r upgrade.txtただ、管理するファイルも増えるのでオフライン環境下でもない限りはdockerfileに直接書いた方がいい。

実行確認

importできるか確認。shellファイルにしておいて

RUNコマンド実行に直接叩く。import_test.sh#!/bin/sh python -c "import numpy" python -c "import scipy" python -c "import h5py" python -c "import pandas" python -c "import matplotlib" python -c "import sklearn"後始末

dockerイメージの軽量化のため余分なファイル削除

whlのビルドに使っていたイメージは生成物さえ残っていればいいので他は全部消す。builder-imageapk del --purge .build .testing_build pip freeze | xargs pip uninstall -y pip cache purge余分なファイルを削除した事で、ビルドしたイメージがどれだけ軽くなったか確認。360MBほど減量に成功した模様

# docker images REPOSITORY TAG IMAGE ID CREATED SIZE naka345/wheel_build latest b6c9df898334 9 minutes ago 1.04GB naka345/wheel_build latest 3236cf2f87de 2 days ago 639MB次は実行環境側の整理。

公式のpython dockerがとてもスマートなので、これに倣ってファイルを消し込んでいく。3execution-image# モジュールに必要なファイルだけ新しい仮想パッケージとして括り、 find /usr/local -type f -executable -not \( -name '*tkinter*' \) -exec scanelf --needed --nobanner --format '%n#p' '{}' ';' \ | tr ',' '\n' \ | sort -u \ | awk 'system("[ -e /usr/local/lib/" $1 " ]") == 0 { next } { print "so:" $1 }' \ | xargs -rt apk add --no-cache --virtual .module-rundeps && \ # ビルド時に使っていたパッケージ群は全て消す apk del --purge .build .community_build # python側の余分なファイルやゴミの削除 find /usr/local -depth \ \( \ \( -type d -a \( -name test -o -name tests -o -name idle_test \) \) \ -o \ \( -type f -a \( -name '*.pyc' -o -name '*.pyo' \) \) \ \) -exec rm -rf '{}' + # 今回の実行範囲分のゴミ掃除 rm -rf /tmp/whl実行環境側で消さなかった時との比較をしてみる。

# docker images REPOSITORY TAG IMAGE ID CREATED SIZE naka345/wheel_install latest f0df8a9887de 3 hours ago 1.29GB ↓ naka345/wheel_install latest 27b4805053f2 3 hours ago 968MBなんとか1GB以下に抑えることができた。

dockerfileにしてみる

上記を踏まえてdockerfileに書き下す。

長くなるのでgithubのリンクを貼っておしまい。まとめ

時間がかかるモジュールもpip経由で安全に比較的手早く持ち込めるようにした。

dockerイメージも多少軽量化できた。ただし、イメージを複数持たないといけない部分は据え置き。

requirements.txtの整合性が要になるので、

こいつが更新されたタイミングでdocker hubに両イメージがpushされる仕組みがあれば楽になれるのかな?参考文献

- 投稿日:2020-05-26T16:14:37+09:00

multi stage build でpythonのC言語依存モジュールを wheel形式でインストールする

背景

alpineでC言語依存モジュールを pip install すると激重になる話

- alpineだと上記事象が避けられない

- multi stage buildで生成物を引っ張ってくるのが折衷案として良さそう

- 生成物を再利用する方法が安全ではない

- ベースイメージから生成物をベタに

COPYしている部分をやめる*.whlを持ってきて安全にインストールする方法を採ってみる- ついでに小手先技でimageを軽くしてみる

手順

- alpineイメージ上で必要モジュールをビルド

- 生成物(wheelファイル)は再利用しやすいように一箇所にまとめる

- ビルド完了済みイメージとして docker hub に push

- 実行環境用のalpineに multi stage build でwheelのディレクトリだけ取得しインストール

- 実行確認とお掃除

実装

まずは、必要なモジュール郡の取得から

今回は以下のモジュールを導入してみるrequirements.txtcycler==0.10.0 Cython==0.29.17 h5py==2.10.0 joblib==0.14.1 kiwisolver==1.2.0 matplotlib==3.2.1 numpy==1.18.4 pandas==1.0.3 Pillow==7.1.2 pyparsing==2.4.7 python-dateutil==2.8.1 pytz==2020.1 scikit-learn==0.22.2.post1 scipy==1.3.3 six==1.14.0必要モジュールを一箇所に集める

alpineの場合だとc言語依存モジュールはtarやzipなどの圧縮形式が落ちてくる。

これらをwhl形式に変換しておく必要がある。下準備

whlに変換時に必要なライブラリが存在するはずなので、apk経由でinstallしておく

apk update \ && apk add --virtual .build --no-cache openblas-dev lapack-dev freetype-dev ... && apk add --virtual .community_build --no-cache -X http://dl-cdn.alpinelinux.org/alpine/edge/community hdf5-dev必要なwhlファイルを用意する

pip downloadでもモジュールのダウンロードを実行できるが、

pip wheelコマンドだとダウンロードとtar/zipファイルを自動展開してビルドまで行ってくれるのでこちらを使用。

pip wheelも-rオプションを使用できるのでpip freeze > requirements.txtなどでバージョニングファイルを指定する。pip wheel --no-cache --wheel-dir=./whl -r requirements.txt

- オプション補足

--no-cache-dir: キャッシュを使用・作成をしない。指定しないと~/.tmpとかにもりもりキャッシュされる。ビルド時の生成物もキャッシュされる。--wheel-dir: wheelファイルのアウトプット先。pip wheelを使用する場合の補足

残念ながら今回の場合は途中で失敗する

別alpine環境で構築しpip freezeしたrequirements.txtを使用しているのだが、

numpy,scipyが使用できる環境でないためscikit-learnビルド中に落ちる。

pip install -r requirements.txtだとpip側がよしなにインストールしてくれるが1

今回に限っては先に依存モジュールを入れておくしか無い。2pip install cython numpy==1.18.4 scipy==1.3.3 pip wheel --no-cache --wheel-dir=./whl -r requirements.txtnumpyやscipyのビルドを回避するために別途イメージを作ろうとしていたのに

なんだか無意味なことをしている気がしてきたぞ...?ビルド完了後

docker hubにpush適当にタギングしてpush

docker tag 123456789a hoge/builder-image:latest docker push hoge/builder-image:latest実行環境用に生成物を持ってくる

ここからは実行環境用のdockerfile上で作業していく。

ローカルディレクトリのwheelをインストール

pip installで複数モジュールを指定するにはベタ書きしていくか--requirementでテキストファイルを指定する。

適当なディレクトリにwhlを集めて丸ごとインストールできるような仕様は無い。今回はマルチステージビルドでwheelが入ったディレクトリを

COPYし下記コマンドを実行することでローカルのwheelからインストールする。pip install --no-index --no-deps --no-cache-dir -f ./whl -r requirement.txt

- オプション補足

--no-index: PyPiのようなインデックスサイトを使わない。オンラインを経由したくない時に使う--no-deps: 依存モジュールをインストールしない。ただし、モジュール側で明確に指定されている場合はその限りでない模様。-f,--find-links: モジュールの検索先を指定。ローカルパスを指定したい時はこれを使う--upgrade で対応するモジュール

pipやsetuptoolsなど

--upgradeオプションをつけて導入したいモジュールはアップグレード用のテキストファイルに分けて導入する。

-rオプションで参照するテキストファイルはバージョン指定無しでもインストールは可能だ。upgrade.txtpip setuptools wheel下記コマンドで特定ディレクトリにまとめたモジュールをupgrade

pip install -U --no-index --no-deps --no-cache-dir -f ./upgrade -r upgrade.txtただ、管理するファイルも増えるのでオフライン環境下でもない限りはdockerfileに直接書いた方がいい。

実行確認

importできるか確認。shellファイルにしておいて

RUNコマンド実行に直接叩く。import_test.sh#!/bin/sh python -c "import numpy" python -c "import scipy" python -c "import h5py" python -c "import pandas" python -c "import matplotlib" python -c "import sklearn"後始末

dockerイメージの軽量化のため余分なファイル削除

whlのビルドに使っていたイメージは生成物さえ残っていればいいので他は全部消す。builder-imageapk del --purge .build .testing_build pip freeze | xargs pip uninstall -y pip cache purge余分なファイルを削除した事で、ビルドしたイメージがどれだけ軽くなったか確認。360MBほど減量に成功した模様

# docker images REPOSITORY TAG IMAGE ID CREATED SIZE naka345/wheel_build latest b6c9df898334 9 minutes ago 1.04GB naka345/wheel_build latest 3236cf2f87de 2 days ago 639MB次は実行環境側の整理。

公式のpython dockerがとてもスマートなので、これに倣ってファイルを消し込んでいく。3execution-image# モジュールに必要なファイルだけ新しい仮想パッケージとして括り、 find /usr/local -type f -executable -not \( -name '*tkinter*' \) -exec scanelf --needed --nobanner --format '%n#p' '{}' ';' \ | tr ',' '\n' \ | sort -u \ | awk 'system("[ -e /usr/local/lib/" $1 " ]") == 0 { next } { print "so:" $1 }' \ | xargs -rt apk add --no-cache --virtual .module-rundeps && \ # ビルド時に使っていたパッケージ群は全て消す apk del --purge .build .community_build # python側の余分なファイルやゴミの削除 find /usr/local -depth \ \( \ \( -type d -a \( -name test -o -name tests -o -name idle_test \) \) \ -o \ \( -type f -a \( -name '*.pyc' -o -name '*.pyo' \) \) \ \) -exec rm -rf '{}' + # 今回の実行範囲分のゴミ掃除 rm -rf /tmp/whl実行環境側で消さなかった時との比較をしてみる。

# docker images REPOSITORY TAG IMAGE ID CREATED SIZE naka345/wheel_install latest f0df8a9887de 3 hours ago 1.29GB ↓ naka345/wheel_install latest 27b4805053f2 3 hours ago 968MBなんとか1GB以下に抑えることができた。

dockerfileにしてみる

上記を踏まえてdockerfileに書き下す。

長くなるのでgithubのリンクを貼っておしまい。まとめ

時間がかかるモジュールもpip経由で安全に比較的手早く持ち込めるようにした。

dockerイメージも多少軽量化できた。ただし、イメージを複数持たないといけない部分は据え置き。

requirements.txtの整合性が要になるので、

こいつが更新されたタイミングでdocker hubに両イメージがpushされる仕組みがあれば楽になれるのかな?参考文献

- 投稿日:2020-05-26T15:26:27+09:00

コンテナ設計方針をまとめてみた

Docker化にあたって

全てDocker化できるわけではない

- ステートレスなものは向いている

- コンテナはステートレス

- 極力手作業なしの形で実装する

環境変数を活用する

アプリケーションの挙動を環境変数で制御する

手法

- 実引数

- 設定ファイル

- 設定ファイルに環境変数を埋め込む永続化データの扱い

- Data Volumeとしてホストと共有する

- Data Volumeコンテナとして独立させる

セキュリティ

- OFFICIALイメージを使う

- Docker Bench for Securityでチェックを行う

脆弱性が混入する恐れがあるのでdokerfileにはADDは使わない

- COPY推奨

- ADDを使うならチェックサムを併用する

適切なアクセス制御を設定する

- rootログイン禁止

- ACLを設定する

- VPNを併用する

Dockerデーモンにアクセスできることになるので、/var/run/docker.sockを共有しない

アプリケーション実行ユーザを用意し、rootユーザのままで実行しない

機密情報の扱い

- 環境変数(要暗号化)

- 外部から(暗号化S3バケット等)

ポータビリティ(≒冪等性)

絶対ではない

冪等性を損ねる要素

- Kernelの違い

- アーキテクテャの違い

ARMアーキテクチャ向けのDockerコンテナイメージをWindows/Macでビルドする- ダイナミックリンクライブラリ

- 極力スタティックリンクを使う

コンテナの粒度

1コンテナ = 1関心事

1コンテナ=1プロセスではうまくいかないことも

プロセスを過剰に意識しないこと

1つのロール or 1つのドメインに収まる粒度で

より軽いコンテナを

コンテナが重いことの弊害

オートスケールでのサービスインまで時間がかかる

ビルドに時間がかかる

プッシュに時間がかかる

ホストへにデプロイするのに時間がかかる

ディスク容量を無駄に消費する

CIに要する時間が増加する

→ 塵も積もれば、生産性が低下する

軽量ベースイメージ

scratch

- 機能が限定的すぎる

BusyBox

- 標準Cライブラリ別にイメージが作られている

- パッケージマネージャなし

Alpine Linux

- デファクトスタンダード

dlstroless

コンテナサイズの削減手法

アプリケーションのサイズを削減する

- 不要ファイルの削除

- 不要プログラムの削除

- 依存ライブラリの削減

- web asset(主に画像)のサイズ削減

.dockerignoreを定義する

Doker build時のレイヤ構造を削減する

RUNで個別に実行する → "&&"で結合して実行する

FROM alpine:xx.yy RUN apk add --no-cache wget RUN wget https:// hoge.com/fuga.tgz RUN tar -xvzf fuga.tgz RUN rm fuga.tgz RUN mv fuga /bin/fuga RUN chmod +x /bin/fuga RUN fuga --symlink↓

FROM alpine:xx.yy RUN apk add --no-cache wget &&\ wget https:// hoge.com/fuga.tgz &&\ tar -xvzf fuga.tgz &&\ rm fuga.tgz &&\ mv fuga /bin/fuga &&\ chmod +x /bin/fuga &&\ fuga --symlink可読性とトレードオフになる

multi-stage builds

- ビルド用コンテナと実行コンテナを分離する

- ビルド用コンテナで制作したファイルは実行コンテナにコピーし、ビルド用コンテナは破棄される

= ビルド用にのみ必要なツールをインストールするレイヤは、実行コンテナに存在しなくてよいFROM golang:xx AS build WORKDIR / COPY ./go/src/hoge.com/fuga/piyo RUN go get github.com/go-sql-driver/mysql RUN go get hoge.in/gorp.v1 RUN cd /go/src/hoge.com/fuga/piyo && go build -o bin/piyo cmd/main.go FROM alpine:yy COPY --from = build /go/src/hoge.com/fuga/fuga/bin/piyo /usr/local/bin/ CMD ["piyo"]本番環境適用以外のコンテナ活用法

- 開発環境の統一・共有

- CLIの利用

- Win・MacでLinuxでしか動かないツールを使う手段

- シェルスクリプト

- 負荷テスト

参考

- 投稿日:2020-05-26T13:56:09+09:00

docker back to the basic

TL;DR

以下のようなコマンドを使いこなそう

参考) http://docs.docker.jp/engine/reference/commandline/index.html

$ docker image ls $ docker container ls $ docker container ls -a $ docker run -id --name hoge --rm -v $(pwd):/home $ docker container exec $ docker container attach $ docker build -t [image-name] .基礎知識

コンテナ型の仮想化では、コンテナはホストOSのカーネルを利用する。

1コンテナ1プロセスで使用する。

Web server container やDB server container など複数のコンテナを立てる。

コンテナにはそれぞれ仮想NIC(eth0)が割り当てられる。

コンテナ同士で通信することが可能である。

NIC(ニック) : 別名 LANカード、Ethernetカード

NICとは、コンピュータなどの機器を通信ネットワーク(LAN)に接続するためのカード型の拡張装置。筐体背面や側面などに用意された拡張スロットなどに挿入して使用する。単にNICといった場合は最も普及しているイーサネット(Ethernet = 有線LANのこと)に接続するためのコネクタ(RJ45)のことを指す。(引用 http://e-words.jp)What is image and what is container?

docker には、imageとcontainerの2つがある。

OSのインストールDVDを仮想化したものがDockerイメージであり、

OSが起動しているサーバを仮想化したものがコンテナに相当する。

基本コマンド

まず、一番簡単なHello Worldをやってみます。

hello-worldというDockerイメージが用意されていますので、

docker run hello-worldコマンドで起動します。$ sudo docker run hello-worldpullしてきたDockerイメージの一覧は

docker image lsコマンドで確認できます。$ docker image ls $ docker container ls -a作成済Dockerコンテナの一覧は

docker container ls -aで確認できます。"-a"は「コンテナ一覧をすべて表示」するためのオプションです。これをつけないと起動中のコンテナしか表示されません。

dockerイメージの削除コマンドは

docker image rm [Repository]

コンテナの削除コマンドはdocker container rm [containerID]$ docker image rm hello-world $ docker container rm 484810ae0812注意)

docker runからの状況から脱するには「ctrlキーを押しながら'pq'と押す」ホスト側との「ディレクトリ共有」

「ホストOSのディレクトリ」と「コンテナ内の/home/」をつなぐ。

「-v」オプションは、ポートフォワード設定の「-p」オプションと同様、コロンの左側(/root/tomcat-container/logs)がホスト側、右側(/share/logs)がコンテナ内のディレクトリを表していて、そのディレクトリが共有されるかたちとなります。

$ docker run -it -d --name hogehoge -v $(pwd):/home ubuntu:16.04 bashdocker container exec

docker container ls -aでまだコンテナが起動している場合、またコンテナに入ることができるはずである。起動しているコンテナに入る方法は2つある。

docker container attachコマンドを使う方法docker container execコマンドを使う方法attachは「ゲストOSの標準入力/標準出力を、ホストOSの標準入力/標準出力とつなげる」という意味です。attachは「既に起動している」1つのプロセスへつなぎに行きます。

$ docker container attach 5 $ ps aux # ctrlキー + 'pq'execは「引数のコマンドを実行する」という意味です。

execでは現在起動しているbashとは別に、新たにbashを起動します。

$ docker container exec -it 5 bash $ ps aux $ exitDockerFile の作り方

Docker imageからDocker containerを作成する際に「必要なパッケージのインストール手順や実行コマンドなど」をスクリプト化したもの。

$ docker build -t workcheckFROM

FROM命令は、以降の命令で使う ベース・イメージ を指定します。あるいは、有効なDockerfileは、1行めをFROM命令で指定する必要があります。イメージとは、あらゆる有効なものが利用できます。 パブリック・リポジトリ から イメージを取得する 方法が一番簡単です。# ubuntu 14.04のイメージを使う FROM ubuntu:14.04MAINTAINER

MAINTAINER命令は、生成するイメージの Author (作者)フィールドを指定します。RUN

イメージ作成時に実行するコマンドを書く。

RUN命令は既存イメージ上の新しいレイヤで、あらゆるコマンドを実行し、その結果をコミットする命令です。コミットの結果得られたイメージは、Dockerfileの次のステップで使われます。# update後にapache2をインストール RUN apt update . RUN apt install apache2 -yCMD

DockerfileでCMD命令を一度だけ指定できます。複数のCMDがある場合、最も後ろのCMDのみ有効です。

CMDの主な目的は、 コンテナ実行時のデフォルトを提供します 。 デフォルトには、実行可能なコマンドが含まれているか、あるいは省略されるかもしれません# nodeでサーバを起動する CMD [ "node", "server.js" ]EXPOSE

指定のポートを外部に公開する。

EXPOSE命令は、特定のネットワーク・ポートをコンテナが実行時にリッスンすることを Docker に伝えます。EXPOSEがあっても、これだけではホストからコンテナにアクセスできるようにしません。アクセスするには、-pフラグを使ってポートの公開範囲を指定するか、-Pフラグで全ての露出ポートを公開する必要があります。# 80番ポートを外部に公開する EXPOSE 80ENV

ENV命令は、環境変数と 値のセットです。値はDockerfileから派生する全てのコマンド環境で利用でき、 インラインで置き換え も可能です。

ENV命令は2つの形式があります。1つめは、ENVであり、変数に対して1つの値を設定します。はじめの空白以降の文字列が `` に含まれます。ここには空白もクォートも含まれます。2つめの形式は

ENV = ...です。これは一度に複数の変数を指定できます。先ほどと違い、構文の2つめにイコールサイン(=)があるので気を付けてください。コマンドラインの分割、クォート、バックスラッシュは、空白スペースも含めて値になります。ENV <key> <value> ENV <key>=<value> ...ADD

ADD命令は<ソース>にある新しいファイルやディレクトリをコピー、あるいはリモートの URL からコピーします。それから、コンテナ内のファイルシステム上にある送信先に指定されたパスに追加します。複数の

<ソース>リソースを指定できます。この時、ファイルやディレクトリはソースディレクトリ(構築時のコンテクスト)からの相対パス上に存在しないと構築できません。それぞれの

<ソース>にはワイルドカードと Go 言語の filepath.Match ルールに一致するパターンが使えます。例えば、次のような記述です。ADD hom* /mydir/ # "hom" で始まる全てのファイルを追加 ADD hom?.txt /mydir/ # ? は1文字だけ一致します。例: "home.txt" ADD test relativeDir/ # "test" を `WORKDIR`/relativeDir/ (相対ディレクトリ)に追加 ADD test /absoluteDir/ # "test" を /absoluteDir/ (絶対ディレクトリ)に追加COPY

COPY命令は<ソース>にある新しいファイルやディレクトリをコピーするもので、コンテナ内のファイルシステム上にある<送信先>に指定されたパスに追加します。COPY hom* /mydir/ # "hom" で始まる全てのファイルを追加 COPY hom?.txt /mydir/ # ? は1文字だけ一致します。例: "home.txt"例) Node.jsのアプリケーションを起動する

FROM node:12 # アプリケーションディレクトリを作成する WORKDIR /usr/src/app # アプリケーションの依存関係をインストールする # ワイルドカードを使用して、package.json と package-lock.json の両方が確実にコピーされるようにします。 # 可能であれば (npm@5+) COPY package*.json ./ RUN npm install # 本番用にコードを作成している場合 # RUN npm install --only=production # アプリケーションのソースをバンドルする COPY . . EXPOSE 8080 CMD [ "node", "server.js" ]

- 投稿日:2020-05-26T13:29:21+09:00

Dockerで構築したRailsアプリをGitHub Actionsで高速にCIする為のプラクティス(Rails 6 API編)

Rails on GitHub Actions(或いは {Django,Laravel} on GitHub Actions)のCI事例として、

- ホストランナー上にRuby(Python, PHP)をセットアップ

- MySQLやRedisはサービスコンテナで立ち上げ

- 依存ライブラリのインストール(

bundle install) や ユニットテスト(rspec) もホストランナー上で直接実行という事例は多く見かけるのですが、開発をDockerベースで行っていて、GitHub ActionsのCI Pipelineも同じくDockerベースで構築したい...というケースの事例があまり見当たらなかったので、自分が関わったプロジェクト(Rails 6 API mode)での事例を紹介します。

Requirements

- 開発環境は全てDocker(Dockerfile/docker-compose.yml)で構築&管理したい

bundle installやrails sやrspecなどのコマンドは全てdocker-compose {run,exec}を介してコンテナ内で実行する(したい)- Dockerイメージのサイズを小さくしたい

- Dockerイメージ自体でファイルを抱え込むような処理はなるべく書かない。実行したいコマンドはコンテナ起動時に都度コマンドとして付与し、成果物を保存・永続化したければ

volumesを活用する- 「

bundle install,rails db:prepareを実行して環境をセットアップする為のコンテナ」「rails sする為のコンテナ」という具合に用途でコンテナを分ける "1イメージ : Nコンテナ" 想定で- GitHub ActionsでのCIも開発環境と同じ Dockerfile/docker-compose.yml をそのまま活用してセットアップしたい

- CIでも

bundle installやrails sやrspecなどのコマンドは全てdocker-compose {run,exec}を介してコンテナ内で実行する(したい)- 「CI用のDockerfile」とか「CI時だけoverrideする為のdocker-compose.yml」は極力作りたくない

- GitHub ActionsではDockerイメージや依存ライブラリのキャッシュを有効活用してCIを高速化したい

Version

- Ruby 2.7.1

- gem 3.1.3

- bundler 2.1.4

- Rails 6.0.3 (API mode)

- Docker (Docker for Mac)

- Engine 19.03.8

- Compose 1.25.5

- MySQL 8.0.20

Dockerfile

./Dockerfile# このDockerfileとdocker-compose.ymlの書き方については、 # TechRachoさんの記事 https://techracho.bpsinc.jp/hachi8833/2019_09_06/79035 # で紹介されていた手法をベースにしています。(感謝) ARG ARG_RUBY_VERSION FROM ruby:${ARG_RUBY_VERSION}-alpine3.11 # hadolint ignore=DL3008,DL3018 RUN apk update && \ apk add --update --no-cache \ build-base \ bash \ curl \ git \ less \ tzdata \ mysql-client \ mysql-dev && \ rm -rf /var/cache/apk/* SHELL ["/bin/bash", "-eo", "pipefail", "-c"] ARG ARG_TZ=Asia/Tokyo RUN cp /usr/share/zoneinfo/${ARG_TZ} /etc/localtime ARG ARG_GEM_HOME=/bundle ENV GEM_HOME=${ARG_GEM_HOME} ENV BUNDLE_JOBS=4 \ BUNDLE_RETRY=3 \ BUNDLE_PATH=${GEM_HOME} \ BUNDLE_BIN=${GEM_HOME}/bin \ BUNDLE_APP_CONFIG=${GEM_HOME} \ LANG=C.UTF-8 \ LC_ALL=C.UTF-8 ARG ARG_BUNDLER_VERSION="2.1.4" RUN gem update --system && \ gem install bundler:${ARG_BUNDLER_VERSION} ENV APP_ROOT=/app RUN mkdir ${APP_ROOT} ENV PATH=${APP_ROOT}/bin:${BUNDLE_BIN}:${GEM_HOME}/gems/bin:${PATH} WORKDIR ${APP_ROOT} ENV RAILS_ENV=development ARG ARG_COMPOSE_WAIT_VER=2.7.3 ADD https://github.com/ufoscout/docker-compose-wait/releases/download/${ARG_COMPOSE_WAIT_VER}/wait /wait RUN chmod +x /waitアプリのファイルをイメージに含めない

CMDやENTRYPOINTによる処理は定義せず、Railsアプリが動く環境を整える事にのみ特化してイメージのサイズを小さくしています。bundle installやrails sといった処理はdocker-compose {run,exec}を介してコンテナ内で実行し、ライブラリやアプリのファイルはvolumesでマウントしてコンテナにコピーする(イメージには含めないようにする)事を意図しています。ufoscout/docker-compose-wait でDB起動を待つ

ARG ARG_COMPOSE_WAIT_VER=2.7.3 ADD https://github.com/ufoscout/docker-compose-wait/releases/download/${ARG_COMPOSE_WAIT_VER}/wait /wait RUN chmod +x /waitDockerfileの末尾3行部分で ufoscout/docker-compose-wait をインストールしています。これはmysql等のミドルウェア・コンテナのポートがLISTEN状態になるのを待ってくれるRust製のツールで、名前の通りdocker-compose.ymlとの併用が意図されています。

依存ミドルウェア起動をどうやって待つか?については、netcatやdockerizeを使った例だったり、公式のPostgresの例ではシェルスクリプトを書いて頑張る例が紹介されていたりしますが(Badの反応が多いのが気になりますが...)、このツールはミドルウェアの追加・削除時もdocker-compose.ymlに少し記述を追加するだけで対応できますし動作も確実性が高くて使い勝手が良かったです。具体的な使い方は後述のdocker-compose.ymlやGitHub Actionsに関する節で解説します。docker-compose.yml

./docker-compose.ymlversion: "3.7" services: db: image: mysql:8.0.20 command: --default-authentication-plugin=mysql_native_password environment: - MYSQL_ROOT_PASSWORD - MYSQL_ALLOW_EMPTY_PASSWORD volumes: - mysql-data:/var/lib/mysql ports: - ${MYSQL_FORWARDED_PORT:-3306}:3306 - ${MYSQL_FORWARDED_X_PORT:-33060}:33060 base: &base build: context: . dockerfile: ./Dockerfile cache_from: - rails6api-development-cache args: ARG_RUBY_VERSION: ${ARG_RUBY_VERSION:-"2.7.1"} image: rails6api-development:0.1.0 tmpfs: - /tmp wait-middleware: &wait-middleware <<: *base environment: WAIT_HOSTS: db:3306 depends_on: - db command: /wait backend: &backend <<: *base stdin_open: true tty: true volumes: - ./:/app:cached - ${GEMS_CACHE_DIR:-bundle-cache}:/bundle - rails-cache:/app/tmp/cache depends_on: - db console: <<: *backend ports: - 3333:3000 command: /bin/bash server: <<: *backend ports: - 3333:3000 command: bash -c "rm -f tmp/pids/server.pid && rails s -b 0.0.0.0" volumes: mysql-data: bundle-cache: rails-cache:1つのDockerfileでdocker-composeの複数サービスを定義する

base: &base build: context: . dockerfile: ./Dockerfile cache_from: - rails6api-development-cache args: ARG_RUBY_VERSION: ${ARG_RUBY_VERSION:-"2.7.1"} image: rails6api-development:0.1.0docker-compose.ymlの

baseサービス以降の記述が先程のDockerfileを利用するサービスの設定になります。Dockerfileの冒頭で入力を期待しているARG_RUBY_VERSIONARGについては、「環境変数で指定されていたらその内容を、未設定時のデフォルト値は2.7.1を」指定するようにargsにて定義しています。

baseサービスは、それ自体がcommandやentrypointによる処理を行ってはおらず、単にビルドする為だけのサービスとして定義しています。&baseとエイリアスを定義している事からも分かるように、これを後続サービスでマージして利用しています(後述)。ビルドに関する設定はこのbaseサービスにのみ集約してあるので、buildセクションの設定はこれ以降のサービスには出てきません。

baseサービスのポイントはcache_fromでrails6api-development-cacheを指定している事です。この設定は開発作業時ではなくCI時での利用を想定したものです。詳細は後述します。wait-middleware: &wait-middleware <<: *base environment: WAIT_HOSTS: db:3306 depends_on: - db command: /waitこのサービス定義が、Dockerfileの最後でインストールしたufoscout/docker-compose-waitを使って

dbサービスの起動を待つ為のサービスです。ymlの定義方法は公式を参照ください。先に定義したbaseサービスをmergeし、docker-compose-waitで必要な設定とdbサービスとの関連を定義しています。単独で実行したい場合はdocker-compose runすればOKです。$ docker-compose run --rm wait-middleware Creating network "rails6api_default" with the default driver Creating rails6api_db_1 ... done -------------------------------------------------------- docker-compose-wait 2.7.3 --------------------------- Starting with configuration: - Hosts to be waiting for: [db:3306] - Timeout before failure: 30 seconds - TCP connection timeout before retry: 5 seconds - Sleeping time before checking for hosts availability: 0 seconds - Sleeping time once all hosts are available: 0 seconds - Sleeping time between retries: 1 seconds -------------------------------------------------------- Checking availability of db:3306 Host db:3306 not yet available... Host db:3306 is now available! -------------------------------------------------------- docker-compose-wait - Everything's fine, the application can now start!上記実行例は筆者のMacでのもので、ほとんど待ちが発生せずdbが立ち上がります。この速さならdepends_on で起動順さえ意識しておけば「DBが立ち上がっていない状態でアプリが動きそうになってエラー」という状況はほぼ発生しないのですが、GitHub ActionsのCI環境ではこの速さでは起動してくれず、

wait-middlewareの効果が大きくなります。これについても後述します。backend: &backend <<: *base stdin_open: true tty: true volumes: - ./:/app:cached - ${GEMS_CACHE_DIR:-bundle-cache}:/bundle - rails-cache:/app/tmp/cache depends_on: - db console: <<: *backend ports: - 3333:3000 command: /bin/bash server: <<: *backend ports: - 3333:3000 command: bash -c "rm -f tmp/pids/server.pid && rails s -b 0.0.0.0" volumes: mysql-data: bundle-cache: rails-cache:bashログインしてのプロンプト作業や

rails sする為のサービス定義と、volumeの定義部分です。TechRachoさんの記事 で紹介されていた書き方を流用させてもらっています。

consoleとserverの両サービスがbackendというサービス定義をマージしているのですが、このbackendのvolumesで${GEMS_CACHE_DIR:-bundle-cache}:/bundleと定義されているvolumeはbundle install先のディレクトリで、「環境変数GEMS_CACHE_DIRがセットされていればその内容で、セットされていなければbundle-cacheという名前のnamed volumeでマウント」する事を意図しており、CIの為にこのような設定を行っています。これも詳細は後述します。.env

./.envMYSQL_ROOT_PASSWORD=root MYSQL_ALLOW_EMPTY_PASSWORD=1 DB_HOST=db MYSQL_FORWARDED_PORT=3806 MYSQL_FORWARDED_X_PORT=38060docker-compose.ymlのdbサービス内の環境変数を.envの内容から展開 しています。

.github/workflows/ci.yml

./.github/workflows/ci.ymlon: push: branches: - master paths-ignore: - '**/*.md' - 'LICENSE' pull_request: paths-ignore: - '**/*.md' - 'LICENSE' env: DOCKER_BUILDKIT: 1 COMPOSE_DOCKER_CLI_BUILD: 1 APP_IMAGE_TAG: rails6api-development:0.1.0 APP_IMAGE_CACHE_TAG: rails6api-development-cache IMAGE_CACHE_DIR: /tmp/cache/docker-image IMAGE_CACHE_KEY: cache-image jobs: image-cache-or-build: strategy: matrix: ruby: ["2.7.1"] os: [ubuntu-18.04] runs-on: ${{ matrix.os }} env: ARG_RUBY_VERSION: ${{ matrix.ruby }} steps: - name: Check out code id: checkout uses: actions/checkout@v2 - name: Generate dotenv id: generate-dotenv run: cp .env.sample .env - name: Cache docker image id: cache-docker-image uses: actions/cache@v1 with: path: ${{ env.IMAGE_CACHE_DIR }} key: ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}-${{ hashFiles('Dockerfile') }} restore-keys: | ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}- - name: Docker load id: docker-load if: steps.cache-docker-image.outputs.cache-hit == 'true' run: docker image load -i ${IMAGE_CACHE_DIR}/image.tar - name: Docker build id: docker-build run: docker-compose build --build-arg BUILDKIT_INLINE_CACHE=1 base - name: Docker tag and save id: docker-tag-save if: steps.cache-docker-image.outputs.cache-hit != 'true' run: mkdir -p ${IMAGE_CACHE_DIR} && docker image tag ${APP_IMAGE_TAG} ${APP_IMAGE_CACHE_TAG} && docker image save -o ${IMAGE_CACHE_DIR}/image.tar ${APP_IMAGE_CACHE_TAG} test-app: needs: image-cache-or-build strategy: matrix: ruby: ["2.7.1"] os: [ubuntu-18.04] runs-on: ${{ matrix.os }} env: ARG_RUBY_VERSION: ${{ matrix.ruby }} GEMS_CACHE_DIR: /tmp/cache/bundle GEMS_CACHE_KEY: cache-gems steps: - name: Check out code id: checkout uses: actions/checkout@v2 - name: Generate dotenv id: generate-dotenv run: cp .env.sample .env - name: Cache docker image id: cache-docker-image uses: actions/cache@v1 with: path: ${{ env.IMAGE_CACHE_DIR }} key: ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}-${{ hashFiles('Dockerfile') }} restore-keys: | ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}- - name: Docker load id: docker-load if: steps.cache-docker-image.outputs.cache-hit == 'true' run: docker image load -i ${IMAGE_CACHE_DIR}/image.tar - name: Docker compose build id: docker-build run: docker-compose build --build-arg BUILDKIT_INLINE_CACHE=1 base - name: Wait middleware services id: wait-middleware run: docker-compose run --rm wait-middleware - name: Confirm docker-compose logs id: confirm-docker-compose-logs run: docker-compose logs db - name: Cache bundle gems id: cache-bundle-gems uses: actions/cache@v1 with: path: ${{ env.GEMS_CACHE_DIR }} key: ${{ runner.os }}-${{ env.GEMS_CACHE_KEY }}-${{ matrix.ruby }}-${{ hashFiles('Gemfile.lock') }} restore-keys: | ${{ runner.os }}-${{ env.GEMS_CACHE_KEY }}-${{ matrix.ruby }}- - name: Setup and Run test id: setup-and-run-test run: docker-compose run --rm console bash -c "bundle install && rails db:prepare && rspec" scan-image-by-trivy: needs: image-cache-or-build strategy: matrix: ruby: ["2.7.1"] os: [ubuntu-18.04] runs-on: ${{ matrix.os }} env: ARG_RUBY_VERSION: ${{ matrix.ruby }} TRIVY_CACHE_DIR: /tmp/cache/trivy steps: - name: Check out code id: checkout uses: actions/checkout@v2 - name: Cache docker image id: cache-docker-image uses: actions/cache@v1 with: path: ${{ env.IMAGE_CACHE_DIR }} key: ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}-${{ hashFiles('Dockerfile') }} restore-keys: | ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}- - name: Docker load id: docker-load if: steps.cache-docker-image.outputs.cache-hit == 'true' run: docker image load -i ${IMAGE_CACHE_DIR}/image.tar - name: Scan image id: scan-image run: docker container run --rm -v /var/run/docker.sock:/var/run/docker.sock -v ${TRIVY_CACHE_DIR}:/root/.cache/ aquasec/trivy ${APP_IMAGE_CACHE_TAG}BuildKitでビルドをちょっと高速化

env: DOCKER_BUILDKIT: 1 COMPOSE_DOCKER_CLI_BUILD: 1グローバルな環境変数でdocker-compose向けにBuildKitを有効化しています。今回のDockerfileはmulti-stageでも無くBuildKitによる恩恵はそこまで大きくはないのですが、有効化した事でビルド時間が速くなった(12%程度削減)ので有効化しています。

先にイメージのキャッシュ・リストアを実行し、このキャッシュで後続ジョブを並列に動かす

jobs: # Dockerイメージのキャッシュ・リストア image-cache-or-build: # アプリのテスト test-app: needs: image-cache-or-build # イメージの脆弱性スキャン scan-image-by-trivy: needs: image-cache-or-build最初に必ずDockerイメージのキャッシュリストア(キャッシュが無ければ新規ビルド→キャッシュ生成)を行い、後続のアプリテスト&イメージスキャンはこのキャッシュからリストアしたイメージを使って実行するようにします。アプリテストとイメージスキャンは並列実行でも構わないので並列にしています。

docker image save, docker image load, cache_from with BuildKit でイメージのキャッシュ・リストアとビルド

jobs: image-cache-or-build: strategy: matrix: ruby: ["2.7.1"] os: [ubuntu-18.04] runs-on: ${{ matrix.os }} env: ARG_RUBY_VERSION: ${{ matrix.ruby }} steps: - name: Check out code id: checkout uses: actions/checkout@v2 - name: Generate dotenv id: generate-dotenv run: cp .env.sample .env - name: Cache docker image id: cache-docker-image uses: actions/cache@v1 with: path: ${{ env.IMAGE_CACHE_DIR }} key: ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}-${{ hashFiles('Dockerfile') }} restore-keys: | ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}-Dockerイメージのキャッシュリストアは、公式のキャッシュ処理用actionであるactions/cacheで行います。キャッシュのキーに

${{ hashFiles('Dockerfile') }}を含めているのは、Dockerfileに変更があった際にキャッシュHITさせないようにする事を意図したものです。env: DOCKER_BUILDKIT: 1 COMPOSE_DOCKER_CLI_BUILD: 1 APP_IMAGE_TAG: rails6api-development:0.1.0 APP_IMAGE_CACHE_TAG: rails6api-development-cache # 略 - name: Docker load id: docker-load if: steps.cache-docker-image.outputs.cache-hit == 'true' run: docker image load -i ${IMAGE_CACHE_DIR}/image.tar - name: Docker build id: docker-build run: docker-compose build --build-arg BUILDKIT_INLINE_CACHE=1 base - name: Docker tag and save id: docker-tag-save if: steps.cache-docker-image.outputs.cache-hit != 'true' run: mkdir -p ${IMAGE_CACHE_DIR} && docker image tag ${APP_IMAGE_TAG} ${APP_IMAGE_CACHE_TAG} && docker image save -o ${IMAGE_CACHE_DIR}/image.tar ${APP_IMAGE_CACHE_TAG}上記step群の処理をまとめると、「ビルドされたイメージに

rails6api-development-cacheというタグを付与してtarに保存し、actions/cache のキャッシュ先ディレクトリに image.tar という名前で保存する」という処理を行っています。キャッシュHITの有無で処理の流れは下記のように変わります。

- キャッシュがHITしなかった場合

docker-buildのstepで新規にイメージがビルドされます

- ※

--build-arg BUILDKIT_INLINE_CACHE=trueオプションを指定している理由は、BuildKitが有効化された状態でビルドされたイメージをcache_fromで取り込むには、元のイメージがこのオプション付きでビルドされている必要がある為です- 実際に

cache_fromが指定されているのは、docker-compose.ymlのbaseサービスのbuild設定の箇所(=rails6api-development-cache)- actions/cacheでキャッシュ先として指定した

${IMAGE_CACHE_DIR}をmkdirします- ビルド結果のイメージに別途「キャッシュ用のタグ」を付与します

- =

APP_IMAGE_CACHE_TAG=rails6api-development-cache- 「キャッシュ用のタグ」 =

rails6api-development-cacheを付与したイメージをdocker image saveで保存します。この保存先にactions/cacheでのキャッシュ先ディレクトリを指定します(ファイル名は image.tar)- キャッシュがHITした場合

docker-loadのstepで、キャッシュからリストアされたimage.tarがdocker image loadによって展開されます

- 展開されるイメージには「キャッシュ用のタグ」 =

rails6api-development-cacheが付与されていますdocker-buildのstepでイメージがビルドされますが、先のloadのstepで展開されたイメージによってcache_fromrails6api-development-cacheの指定が効き、このビルドはすぐに終わります- tagとsaveのstepは

if: steps.cache-docker-image.outputs.cache-hit != 'true'の指定によりSKIPされますキャッシュ・リストアしたイメージを使って高速CI

env: DOCKER_BUILDKIT: 1 COMPOSE_DOCKER_CLI_BUILD: 1 APP_IMAGE_TAG: rails6api-development:0.1.0 APP_IMAGE_CACHE_TAG: rails6api-development-cache # 略 jobs: # 略 test-app: needs: image-cache-or-build # 略 - name: Cache docker image id: cache-docker-image uses: actions/cache@v1 with: path: ${{ env.IMAGE_CACHE_DIR }} key: ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}-${{ hashFiles('Dockerfile') }} restore-keys: | ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}- - name: Docker load id: docker-load if: steps.cache-docker-image.outputs.cache-hit == 'true' run: docker image load -i ${IMAGE_CACHE_DIR}/image.tar - name: Docker compose build id: docker-build run: docker-compose build --build-arg BUILDKIT_INLINE_CACHE=1 base先述のイメージのビルド&キャッシュjobが完了すると、アプリのテストを行う

test-appが起動します。docker-loadのstepでは「キャッシュ用のタグ」 =rails6api-development-cacheが付与されているイメージが展開され、docker-buildのstepでこのイメージをcache_fromによって取り込んでbaseサービスのイメージ(=rails6api-development:0.1.0タグが付与されたイメージ)をビルドします。ufoscout/docker-compose-wait でMySQLコンテナの起動を待つ

- name: Wait middleware services id: wait-middleware run: docker-compose run --rm wait-middleware - name: Confirm docker-compose logs id: confirm-docker-compose-logs run: docker-compose logs dbDockerfileの最後でインストールしてあるufoscout/docker-compose-waitを使って

dbサービスの起動を待ちます。Starting with configuration: - Hosts to be waiting for: [db:3306] - Timeout before failure: 30 seconds - TCP connection timeout before retry: 5 seconds - Sleeping time before checking for hosts availability: 0 seconds - Sleeping time once all hosts are available: 0 seconds - Sleeping time between retries: 1 seconds -------------------------------------------------------- Checking availability of db:3306 Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 is now available! -------------------------------------------------------- docker-compose-wait - Everything's fine, the application can now start! --------------------------------------------------------以前に「GitHub ActionsのCI環境ではこの速さでは起動してくれず、

wait-middlewareの効果が大きくなります」と書きましたが、上記ログがGitHub Actionsのrunnerインスタンス上での実行例で(Host db:3306 not yet available...でsleepを1秒挟んでいます)、ポート3306のLISTENまでに10秒以上掛かっています。このログ例のみならず、何度実行しても平均的に10秒超は掛かっていました。仮にこの所要時間でwaitするstepを挟まない(depends_onを指定するのみ)とすると、MySQL起動前に後続のRailsアプリに関するstepが走ってしまいエラーになるでしょう。余談: MySQLコンテナの起動プロセスと処理時間

db_1 | 2020-05-25 16:36:40+00:00 [Note] [Entrypoint]: Entrypoint script for MySQL Server 8.0.20-1debian10 started. db_1 | 2020-05-25 16:36:40+00:00 [Note] [Entrypoint]: Switching to dedicated user 'mysql' db_1 | 2020-05-25 16:36:40+00:00 [Note] [Entrypoint]: Entrypoint script for MySQL Server 8.0.20-1debian10 started. db_1 | 2020-05-25 16:36:40+00:00 [Note] [Entrypoint]: Initializing database files db_1 | 2020-05-25T16:36:40.990281Z 0 [Warning] [MY-011070] [Server] 'Disabling symbolic links using --skip-symbolic-links (or equivalent) is the default. Consider not using this option as it' is deprecated and will be removed in a future release. db_1 | 2020-05-25T16:36:40.990349Z 0 [System] [MY-013169] [Server] /usr/sbin/mysqld (mysqld 8.0.20) initializing of server in progress as process 45 db_1 | 2020-05-25T16:36:40.996092Z 1 [System] [MY-013576] [InnoDB] InnoDB initialization has started. db_1 | 2020-05-25T16:36:42.100882Z 1 [System] [MY-013577] [InnoDB] InnoDB initialization has ended. db_1 | 2020-05-25T16:36:43.312805Z 6 [Warning] [MY-010453] [Server] root@localhost is created with an empty password ! Please consider switching off the --initialize-insecure option. db_1 | 2020-05-25 16:36:46+00:00 [Note] [Entrypoint]: Database files initialized db_1 | 2020-05-25 16:36:46+00:00 [Note] [Entrypoint]: Starting temporary server db_1 | 2020-05-25T16:36:46.494377Z 0 [Warning] [MY-011070] [Server] 'Disabling symbolic links using --skip-symbolic-links (or equivalent) is the default. Consider not using this option as it' is deprecated and will be removed in a future release. db_1 | 2020-05-25T16:36:46.494485Z 0 [System] [MY-010116] [Server] /usr/sbin/mysqld (mysqld 8.0.20) starting as process 92 db_1 | 2020-05-25T16:36:46.507413Z 1 [System] [MY-013576] [InnoDB] InnoDB initialization has started. db_1 | 2020-05-25T16:36:46.819578Z 1 [System] [MY-013577] [InnoDB] InnoDB initialization has ended. db_1 | 2020-05-25T16:36:46.915827Z 0 [System] [MY-011323] [Server] X Plugin ready for connections. Socket: '/var/run/mysqld/mysqlx.sock' db_1 | 2020-05-25T16:36:47.015509Z 0 [Warning] [MY-010068] [Server] CA certificate ca.pem is self signed. db_1 | 2020-05-25T16:36:47.017398Z 0 [Warning] [MY-011810] [Server] Insecure configuration for --pid-file: Location '/var/run/mysqld' in the path is accessible to all OS users. Consider choosing a different directory. db_1 | 2020-05-25T16:36:47.034485Z 0 [System] [MY-010931] [Server] /usr/sbin/mysqld: ready for connections. Version: '8.0.20' socket: '/var/run/mysqld/mysqld.sock' port: 0 MySQL Community Server - GPL. db_1 | 2020-05-25 16:36:47+00:00 [Note] [Entrypoint]: Temporary server started. db_1 | Warning: Unable to load '/usr/share/zoneinfo/iso3166.tab' as time zone. Skipping it. db_1 | Warning: Unable to load '/usr/share/zoneinfo/leap-seconds.list' as time zone. Skipping it. db_1 | Warning: Unable to load '/usr/share/zoneinfo/zone.tab' as time zone. Skipping it. db_1 | Warning: Unable to load '/usr/share/zoneinfo/zone1970.tab' as time zone. Skipping it. db_1 | db_1 | 2020-05-25 16:36:49+00:00 [Note] [Entrypoint]: Stopping temporary server db_1 | 2020-05-25T16:36:49.538277Z 10 [System] [MY-013172] [Server] Received SHUTDOWN from user root. Shutting down mysqld (Version: 8.0.20). db_1 | 2020-05-25T16:36:51.341063Z 0 [System] [MY-010910] [Server] /usr/sbin/mysqld: Shutdown complete (mysqld 8.0.20) MySQL Community Server - GPL. db_1 | 2020-05-25 16:36:51+00:00 [Note] [Entrypoint]: Temporary server stopped db_1 | db_1 | 2020-05-25 16:36:51+00:00 [Note] [Entrypoint]: MySQL init process done. Ready for start up. db_1 | db_1 | 2020-05-25T16:36:51.806387Z 0 [Warning] [MY-011070] [Server] 'Disabling symbolic links using --skip-symbolic-links (or equivalent) is the default. Consider not using this option as it' is deprecated and will be removed in a future release. db_1 | 2020-05-25T16:36:51.806498Z 0 [System] [MY-010116] [Server] /usr/sbin/mysqld (mysqld 8.0.20) starting as process 1 db_1 | 2020-05-25T16:36:51.816008Z 1 [System] [MY-013576] [InnoDB] InnoDB initialization has started. db_1 | 2020-05-25T16:36:52.191532Z 1 [System] [MY-013577] [InnoDB] InnoDB initialization has ended. db_1 | 2020-05-25T16:36:52.286349Z 0 [System] [MY-011323] [Server] X Plugin ready for connections. Socket: '/var/run/mysqld/mysqlx.sock' bind-address: '::' port: 33060 db_1 | 2020-05-25T16:36:52.341936Z 0 [Warning] [MY-010068] [Server] CA certificate ca.pem is self signed. db_1 | 2020-05-25T16:36:52.345030Z 0 [Warning] [MY-011810] [Server] Insecure configuration for --pid-file: Location '/var/run/mysqld' in the path is accessible to all OS users. Consider choosing a different directory. db_1 | 2020-05-25T16:36:52.363785Z 0 [System] [MY-010931] [Server] /usr/sbin/mysqld: ready for connections. Version: '8.0.20' socket: '/var/run/mysqld/mysqld.sock' port: 3306 MySQL Community Server - GPL.上記はMySQLコンテナ(

dbサービス)起動時のログをdocker-compose logs dbで確認した際の例です。

Initializing database filesからDatabase files initializedで6秒Starting temporary serverからTemporary server stoppedで5秒この2処理で所要時間をほぼ半分ずつ要しています。

依存gemのvolumeマウントはnamed volumeではなく書き込み可能なディレクトリを使う

env: ARG_RUBY_VERSION: ${{ matrix.ruby }} GEMS_CACHE_DIR: /tmp/cache/bundle GEMS_CACHE_KEY: cache-gems # 略 - name: Cache bundle gems id: cache-bundle-gems uses: actions/cache@v1 with: path: ${{ env.GEMS_CACHE_DIR }} key: ${{ runner.os }}-${{ env.GEMS_CACHE_KEY }}-${{ matrix.ruby }}-${{ hashFiles('Gemfile.lock') }} restore-keys: | ${{ runner.os }}-${{ env.GEMS_CACHE_KEY }}-${{ matrix.ruby }}-依存Gemのキャッシュリストアも、公式のキャッシュ処理用actionであるactions/cacheで行います。キャッシュのキーに

${{ hashFiles('Gemfile.lock') }}を含めているのは、Gemfile.lock(Gemfile)に変更があった際にキャッシュHITさせないようにする事を意図したものです。./docker-compose.ymlbackend: &backend # 略 volumes: - ./:/app:cached - ${GEMS_CACHE_DIR:-bundle-cache}:/bundle - rails-cache:/app/tmp/cache # 略 volumes: mysql-data: bundle-cache: rails-cache:全てをDockerで行おうとしているので、

bundle installもコンテナ内で行います。つまりインストールされたgemをキャッシュしたければ、volume mount先からインストール結果を取り出さなければなりません。↑のdocker-compose.ymlを紹介した際に「環境変数

GEMS_CACHE_DIRがセットされていればその内容で、セットされていなければbundle-cacheという名前のnamed volumeでマウント」と書いたのですが、このcache-bundle-gemsのstepがまさに「環境変数GEMS_CACHE_DIRがセットされていれば」なケースに該当します。これは「named volumeではなくマウント先のパスを環境変数で明示する」のが意図です。公式の

volumesのSHORT SYNTAXによると、パスが指定されていればそのパスが、固定文字列が指定されていればその名前のnamed volumeが、それぞれマウントされます。開発作業時はGEMS_CACHE_DIRを明示せずデフォルトの固定文字列(= named volume =bundle-cache)を使用しても良いですが、actions/cache で内容をキャッシュしようとした場合、そのディレクトリとしてnamed volumeの実体(具体的には/var/lib/docker/volumes/xxxというパス)を指定するとpermission deniedエラーでキャッシュに失敗してしまいます。なのでこれを回避する為にCI時のみGEMS_CACHE_DIRとして/tmp/cache/bundleという(permission deniedにならない)ディレクトリを明示しています。これによりCI時のbundle install結果はこのGEMS_CACHE_DIRディレクトリに出力され、actions/cacheでディレクトリが丸ごとキャッシュされます。この記述は正直分かりやすいとは言えないので、LONG SYNTAXを利用して分かりにくさを軽減したいところなのですが、今回は「環境変数の中身によってvolume typeが変えられる」「1つのdocker-compose.ymlを開発作業とCIで併用しやすい」というメリットを優先してSHORT SYNTAXを採用しました。

アプリのセットアップ&テストもDockerコンテナ内で実行

- name: Setup and Run test id: setup-and-run-test run: docker-compose run --rm console bash -c "bundle install && rails db:prepare && rspec"このstepは構築するアプリの仕様ややりたい事次第で変わると思いますが、一応今回の例を紹介しておくと

bundle install(結果は先述の通りキャッシュされる) →db:prepareでDBセットアップ(参考) → テスト(今回使ったアプリではrspecを使用しています)、という順にテストまで実施しています。それぞれのコマンドをrunnerインスタンス上で直接実行するのではなく、docker-compose runでconsoleサービスを立ち上げてその中で実行するようにしています。アプリのテストと並列でDockerイメージの脆弱性スキャンも実行

env: DOCKER_BUILDKIT: 1 COMPOSE_DOCKER_CLI_BUILD: 1 APP_IMAGE_TAG: rails6api-development:0.1.0 APP_IMAGE_CACHE_TAG: rails6api-development-cache IMAGE_CACHE_DIR: /tmp/cache/docker-image IMAGE_CACHE_KEY: cache-image # 略 scan-image-by-trivy: needs: image-cache-or-build strategy: matrix: ruby: ["2.7.1"] os: [ubuntu-18.04] runs-on: ${{ matrix.os }} env: ARG_RUBY_VERSION: ${{ matrix.ruby }} TRIVY_CACHE_DIR: /tmp/cache/trivy steps: - name: Check out code id: checkout uses: actions/checkout@v2 - name: Cache docker image id: cache-docker-image uses: actions/cache@v1 with: path: ${{ env.IMAGE_CACHE_DIR }} key: ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}-${{ hashFiles('Dockerfile') }} restore-keys: | ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}- - name: Docker load id: docker-load if: steps.cache-docker-image.outputs.cache-hit == 'true' run: docker image load -i ${IMAGE_CACHE_DIR}/image.tar - name: Scan image id: scan-image run: docker container run --rm -v /var/run/docker.sock:/var/run/docker.sock -v ${TRIVY_CACHE_DIR}:/root/.cache/ aquasec/trivy ${APP_IMAGE_CACHE_TAG}開発〜CIをDockerで完結させようとしているので、折角なのでCI時にDockerイメージの脆弱性スキャンも行っておきたいです。今回は aquasecurity/trivy を使わせてもらいました。Docker完結を目指しているので、trivyによるスキャンも公式に提供されているDockerで行います。

needs: image-cache-or-buildによってイメージビルド&キャッシュが完了済なので、スキャンもそのキャッシュをload・展開したイメージに対して実施して高速化します(スキャン対象として${APP_IMAGE_CACHE_TAG}=rails6api-development-cacheを指定)。

毎回 aquasec/trivy をpullする事でスキャンそのものの仕様を常に最新化しているので、Dockerfileに変更がなくてもスキャンを実行するようにしています。開発作業のユースケース例

新規参画エンジニアの環境構築手順は?

# ビルド docker-compose build base # セットアップ docker-compose run --rm console bash -c "bundle install && rails db:prepare && rails db:seed" # 起動 docker-compose up -d serverrailsを起動したい時は?

docker-compose up -d server起動中のRailsログをコンソールに流しておきたい時は?

# 下記コマンドでattachすれば、server コンテナの標準出力をtail風に確認可能 docker attach `docker-compose ps -q server` # attach状態を終了したければ Ctrl+P => Ctrl+Q するテスト(rspec)を実行したい時は?

起動中のserverサービスで

docker-compose exec server rspec [SPEC_FILES]consoleサービスで

docker-compose run --rm console rspec [SPEC_FILES]Rails consoleに接続したい時は?

起動中のserverサービスで

docker-compose exec server rails cマイグレーションを追加・修正・適用したい時は?

起動中のserverサービスで

# マイグレーション新規生成 docker-compose exec server rails g migration MIGRATION_NAME # : # マイグレーションファイルを適宜修正 # : # マイグレーションの適用 docker-compose exec server rails db:migrate

- 投稿日:2020-05-26T13:29:21+09:00

開発もGitHub ActionsでのCIも全てDockerで行う (Rails 6 API編)

Rails on GitHub Actions(或いは {Django,Laravel} on GitHub Actions)のCI事例として、

- ホストランナー上にRuby(Python, PHP)をセットアップ

- MySQLやRedisはサービスコンテナで立ち上げ

- 依存ライブラリのインストール(

bundle install) や ユニットテスト(rspec) もホストランナー上で直接実行という事例は多く見かけるのですが、開発をDockerベースで行っていて、GitHub ActionsのCI Pipelineも同じくDockerベースで構築したい...というケースの事例があまり見当たらなかったので、自分が関わったプロジェクト(Rails 6 API mode)での事例を紹介します。

Requirements

- 開発環境は全てDocker(Dockerfile/docker-compose.yml)で構築&管理したい

bundle installやrails sやrspecなどのコマンドは全てdocker-compose {run,exec}を介してコンテナ内で実行する(したい)- Dockerイメージのサイズを小さくしたい

- Dockerイメージ自体でファイルを抱え込むような処理はなるべく書かない。実行したいコマンドはコンテナ起動時に都度コマンドとして付与し、成果物を保存・永続化したければ

volumesを活用する- 「

bundle install,rails db:prepareを実行して環境をセットアップする為のコンテナ」「rails sする為のコンテナ」という具合に用途でコンテナを分ける "1イメージ : Nコンテナ" 想定で- GitHub ActionsでのCIも開発環境と同じ Dockerfile/docker-compose.yml をそのまま活用してセットアップしたい

- CIでも

bundle installやrails sやrspecなどのコマンドは全てdocker-compose {run,exec}を介してコンテナ内で実行する(したい)- 「CI用のDockerfile」とか「CI時だけoverrideする為のdocker-compose.yml」は極力作りたくない

- GitHub ActionsではDockerイメージや依存ライブラリのキャッシュを有効活用してCIを高速化したい

Version

- Ruby 2.7.1

- gem 3.1.3

- bundler 2.1.4

- Rails 6.0.3 (API mode)

- Docker (Docker for Mac)

- Engine 19.03.8

- Compose 1.25.5

- MySQL 8.0.20

Contents

Dockerfile

./Dockerfile# このDockerfileとdocker-compose.ymlの書き方については、 # TechRachoさんの記事 https://techracho.bpsinc.jp/hachi8833/2019_09_06/79035 # で紹介されていた手法をベースにしています。(感謝) ARG ARG_RUBY_VERSION FROM ruby:${ARG_RUBY_VERSION}-alpine3.11 # hadolint ignore=DL3008,DL3018 RUN apk update && \ apk add --update --no-cache \ build-base \ bash \ curl \ git \ less \ tzdata \ mysql-client \ mysql-dev && \ rm -rf /var/cache/apk/* SHELL ["/bin/bash", "-eo", "pipefail", "-c"] ARG ARG_TZ=Asia/Tokyo RUN cp /usr/share/zoneinfo/${ARG_TZ} /etc/localtime ARG ARG_GEM_HOME=/bundle ENV GEM_HOME=${ARG_GEM_HOME} ENV BUNDLE_JOBS=4 \ BUNDLE_RETRY=3 \ BUNDLE_PATH=${GEM_HOME} \ BUNDLE_BIN=${GEM_HOME}/bin \ BUNDLE_APP_CONFIG=${GEM_HOME} \ LANG=C.UTF-8 \ LC_ALL=C.UTF-8 ARG ARG_BUNDLER_VERSION="2.1.4" RUN gem update --system && \ gem install bundler:${ARG_BUNDLER_VERSION} ENV APP_ROOT=/app RUN mkdir ${APP_ROOT} ENV PATH=${APP_ROOT}/bin:${BUNDLE_BIN}:${GEM_HOME}/gems/bin:${PATH} WORKDIR ${APP_ROOT} ENV RAILS_ENV=development ARG ARG_COMPOSE_WAIT_VER=2.7.3 ADD https://github.com/ufoscout/docker-compose-wait/releases/download/${ARG_COMPOSE_WAIT_VER}/wait /wait RUN chmod +x /waitRailsアプリのファイルをイメージ(Dockerfile)に含めない

CMDやENTRYPOINTによる処理は定義せず、Railsアプリが動く環境を整える事にのみ特化してイメージのサイズを小さくしています。bundle installやrails sといった処理はdocker-compose {run,exec}を介してコンテナ内で実行し、ライブラリやアプリのファイルはvolumesでマウントしてコンテナにコピーする(イメージには含めないようにする)事を意図しています。DB起動を待つ処理用途で ufoscout/docker-compose-wait を導入

ARG ARG_COMPOSE_WAIT_VER=2.7.3 ADD https://github.com/ufoscout/docker-compose-wait/releases/download/${ARG_COMPOSE_WAIT_VER}/wait /wait RUN chmod +x /waitDockerfileの末尾3行部分で ufoscout/docker-compose-wait をインストールしています。これはmysql等のミドルウェア・コンテナのポートがLISTEN状態になるのを待ってくれるRust製のツールで、名前の通りdocker-compose.ymlとの併用が意図されています。

依存ミドルウェア起動をどうやって待つか?については、netcatやdockerizeを使った例だったり、公式のPostgresの例ではシェルスクリプトを書いて頑張る例が紹介されていたりしますが(Badの反応が多いのが気になりますが...)、このツールはミドルウェアの追加・削除時もdocker-compose.ymlに少し記述を追加するだけで対応できますし動作も確実性が高くて使い勝手が良かったです。具体的な使い方は後述のdocker-compose.ymlやGitHub Actionsに関する節で解説します。docker-compose.yml

./docker-compose.ymlversion: "3.7" services: db: image: mysql:8.0.20 command: --default-authentication-plugin=mysql_native_password environment: - MYSQL_ROOT_PASSWORD - MYSQL_ALLOW_EMPTY_PASSWORD volumes: - mysql-data:/var/lib/mysql ports: - ${MYSQL_FORWARDED_PORT:-3306}:3306 - ${MYSQL_FORWARDED_X_PORT:-33060}:33060 base: &base build: context: . dockerfile: ./Dockerfile cache_from: - rails6api-development-cache args: ARG_RUBY_VERSION: ${ARG_RUBY_VERSION:-"2.7.1"} image: rails6api-development:0.1.0 tmpfs: - /tmp wait-middleware: &wait-middleware <<: *base environment: WAIT_HOSTS: db:3306 depends_on: - db command: /wait backend: &backend <<: *base stdin_open: true tty: true volumes: - ./:/app:cached - ${GEMS_CACHE_DIR:-bundle-cache}:/bundle - rails-cache:/app/tmp/cache depends_on: - db console: <<: *backend ports: - 3333:3000 command: /bin/bash server: <<: *backend ports: - 3333:3000 command: bash -c "rm -f tmp/pids/server.pid && rails s -b 0.0.0.0" volumes: mysql-data: bundle-cache: rails-cache:1つのDockerfileでdocker-composeの複数サービスを定義する

base: &base build: context: . dockerfile: ./Dockerfile cache_from: - rails6api-development-cache args: ARG_RUBY_VERSION: ${ARG_RUBY_VERSION:-"2.7.1"} image: rails6api-development:0.1.0docker-compose.ymlの

baseサービス以降の記述が先程のDockerfileを利用するサービスの設定になります。Dockerfileの冒頭で入力を期待しているARG_RUBY_VERSIONARGについては、「環境変数で指定されていたらその内容を、未設定時のデフォルト値は2.7.1を」指定するようにargsにて定義しています。

baseサービスは、それ自体がcommandやentrypointによる処理を行ってはおらず、単にビルドする為だけのサービスとして定義しています。&baseとエイリアスを定義している事からも分かるように、これを後続サービスでマージして利用しています(後述)。ビルドに関する設定はこのbaseサービスにのみ集約してあるので、buildセクションの設定はこれ以降のサービスには出てきません。

baseサービスのポイントはcache_fromでrails6api-development-cacheを指定している事です。この設定は開発作業時ではなくCI時での利用を想定したものです。詳細は後述します。wait-middleware: &wait-middleware <<: *base environment: WAIT_HOSTS: db:3306 depends_on: - db command: /waitこのサービス定義が、Dockerfileの最後でインストールしたufoscout/docker-compose-waitを使って

dbサービスの起動を待つ為のサービスです。ymlの定義方法は公式を参照ください。先に定義したbaseサービスをmergeし、docker-compose-waitで必要な設定とdbサービスとの関連を定義しています。単独で実行したい場合はdocker-compose runすればOKです。$ docker-compose run --rm wait-middleware Creating network "rails6api_default" with the default driver Creating rails6api_db_1 ... done -------------------------------------------------------- docker-compose-wait 2.7.3 --------------------------- Starting with configuration: - Hosts to be waiting for: [db:3306] - Timeout before failure: 30 seconds - TCP connection timeout before retry: 5 seconds - Sleeping time before checking for hosts availability: 0 seconds - Sleeping time once all hosts are available: 0 seconds - Sleeping time between retries: 1 seconds -------------------------------------------------------- Checking availability of db:3306 Host db:3306 not yet available... Host db:3306 is now available! -------------------------------------------------------- docker-compose-wait - Everything's fine, the application can now start!上記実行例は筆者のMacでのもので、ほとんど待ちが発生せずdbが立ち上がります。この速さならdepends_on で起動順さえ意識しておけば「DBが立ち上がっていない状態でアプリが動きそうになってエラー」という状況はほぼ発生しないのですが、GitHub ActionsのCI環境ではこの速さでは起動してくれず、

wait-middlewareの効果が大きくなります。これについても後述します。backend: &backend <<: *base stdin_open: true tty: true volumes: - ./:/app:cached - ${GEMS_CACHE_DIR:-bundle-cache}:/bundle - rails-cache:/app/tmp/cache depends_on: - db console: <<: *backend ports: - 3333:3000 command: /bin/bash server: <<: *backend ports: - 3333:3000 command: bash -c "rm -f tmp/pids/server.pid && rails s -b 0.0.0.0" volumes: mysql-data: bundle-cache: rails-cache:bashログインしてのプロンプト作業や

rails sする為のサービス定義と、volumeの定義部分です。TechRachoさんの記事 で紹介されていた書き方を流用させてもらっています。

consoleとserverの両サービスがbackendというサービス定義をマージしているのですが、このbackendのvolumesで${GEMS_CACHE_DIR:-bundle-cache}:/bundleと定義されているvolumeはbundle install先のディレクトリで、「環境変数GEMS_CACHE_DIRがセットされていればその内容で、セットされていなければbundle-cacheという名前のnamed volumeでマウント」する事を意図しており、CIの為にこのような設定を行っています。これも詳細は後述します。.env

./.envMYSQL_ROOT_PASSWORD=root MYSQL_ALLOW_EMPTY_PASSWORD=1 DB_HOST=db MYSQL_FORWARDED_PORT=3806 MYSQL_FORWARDED_X_PORT=38060docker-compose.ymlのdbサービス内の環境変数を.envの内容から展開 しています。

.github/workflows/ci.yml./.github/workflows/ci.ymlon: push: branches: - master paths-ignore: - '**/*.md' - 'LICENSE' pull_request: paths-ignore: - '**/*.md' - 'LICENSE' env: DOCKER_BUILDKIT: 1 COMPOSE_DOCKER_CLI_BUILD: 1 APP_IMAGE_TAG: rails6api-development:0.1.0 APP_IMAGE_CACHE_TAG: rails6api-development-cache IMAGE_CACHE_DIR: /tmp/cache/docker-image IMAGE_CACHE_KEY: cache-image jobs: image-cache-or-build: strategy: matrix: ruby: ["2.7.1"] os: [ubuntu-18.04] runs-on: ${{ matrix.os }} env: ARG_RUBY_VERSION: ${{ matrix.ruby }} steps: - name: Check out code id: checkout uses: actions/checkout@v2 - name: Generate dotenv id: generate-dotenv run: cp .env.sample .env - name: Cache docker image id: cache-docker-image uses: actions/cache@v1 with: path: ${{ env.IMAGE_CACHE_DIR }} key: ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}-${{ hashFiles('Dockerfile') }} restore-keys: | ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}- - name: Docker load id: docker-load if: steps.cache-docker-image.outputs.cache-hit == 'true' run: docker image load -i ${IMAGE_CACHE_DIR}/image.tar - name: Docker build id: docker-build run: docker-compose build --build-arg BUILDKIT_INLINE_CACHE=1 base - name: Docker tag and save id: docker-tag-save if: steps.cache-docker-image.outputs.cache-hit != 'true' run: mkdir -p ${IMAGE_CACHE_DIR} && docker image tag ${APP_IMAGE_TAG} ${APP_IMAGE_CACHE_TAG} && docker image save -o ${IMAGE_CACHE_DIR}/image.tar ${APP_IMAGE_CACHE_TAG} test-app: needs: image-cache-or-build strategy: matrix: ruby: ["2.7.1"] os: [ubuntu-18.04] runs-on: ${{ matrix.os }} env: ARG_RUBY_VERSION: ${{ matrix.ruby }} GEMS_CACHE_DIR: /tmp/cache/bundle GEMS_CACHE_KEY: cache-gems steps: - name: Check out code id: checkout uses: actions/checkout@v2 - name: Generate dotenv id: generate-dotenv run: cp .env.sample .env - name: Cache docker image id: cache-docker-image uses: actions/cache@v1 with: path: ${{ env.IMAGE_CACHE_DIR }} key: ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}-${{ hashFiles('Dockerfile') }} restore-keys: | ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}- - name: Docker load id: docker-load if: steps.cache-docker-image.outputs.cache-hit == 'true' run: docker image load -i ${IMAGE_CACHE_DIR}/image.tar - name: Docker compose build id: docker-build run: docker-compose build --build-arg BUILDKIT_INLINE_CACHE=1 base - name: Wait middleware services id: wait-middleware run: docker-compose run --rm wait-middleware - name: Confirm docker-compose logs id: confirm-docker-compose-logs run: docker-compose logs db - name: Cache bundle gems id: cache-bundle-gems uses: actions/cache@v1 with: path: ${{ env.GEMS_CACHE_DIR }} key: ${{ runner.os }}-${{ env.GEMS_CACHE_KEY }}-${{ matrix.ruby }}-${{ hashFiles('Gemfile.lock') }} restore-keys: | ${{ runner.os }}-${{ env.GEMS_CACHE_KEY }}-${{ matrix.ruby }}- - name: Setup and Run test id: setup-and-run-test run: docker-compose run --rm console bash -c "bundle install && rails db:prepare && rspec" scan-image-by-trivy: needs: image-cache-or-build strategy: matrix: ruby: ["2.7.1"] os: [ubuntu-18.04] runs-on: ${{ matrix.os }} env: ARG_RUBY_VERSION: ${{ matrix.ruby }} TRIVY_CACHE_DIR: /tmp/cache/trivy steps: - name: Check out code id: checkout uses: actions/checkout@v2 - name: Cache docker image id: cache-docker-image uses: actions/cache@v1 with: path: ${{ env.IMAGE_CACHE_DIR }} key: ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}-${{ hashFiles('Dockerfile') }} restore-keys: | ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}- - name: Docker load id: docker-load if: steps.cache-docker-image.outputs.cache-hit == 'true' run: docker image load -i ${IMAGE_CACHE_DIR}/image.tar - name: Scan image id: scan-image run: docker container run --rm -v /var/run/docker.sock:/var/run/docker.sock -v ${TRIVY_CACHE_DIR}:/root/.cache/ aquasec/trivy ${APP_IMAGE_CACHE_TAG}BuildKitを有効化して(ちょっとだけ)ビルドを高速化

env: DOCKER_BUILDKIT: 1 COMPOSE_DOCKER_CLI_BUILD: 1グローバルな環境変数でdocker-compose向けにBuildKitを有効化しています。今回のDockerfileはmulti-stageでも無くBuildKitによる恩恵はそこまで大きくはないのですが、有効化した事でビルド時間が速くなった(12%程度削減)ので有効化しています。

Dockerイメージのキャッシュ・リストア, アプリのテスト, イメージの脆弱性スキャン, の3ジョブ構成

jobs: # Dockerイメージのキャッシュ・リストア image-cache-or-build: # アプリのテスト test-app: needs: image-cache-or-build # イメージの脆弱性スキャン scan-image-by-trivy: needs: image-cache-or-build最初に必ずDockerイメージのキャッシュリストア(キャッシュが無ければ新規ビルド→キャッシュ生成)を行い、後続のアプリテスト&イメージスキャンはこのキャッシュからリストアしたイメージを使って実行するようにします。アプリテストとイメージスキャンは並列実行でも構わないので並列にしています。

docker image save+docker image load+cache_fromwith BuildKit を駆使したDockerイメージのキャッシュ・リストアjobs: image-cache-or-build: strategy: matrix: ruby: ["2.7.1"] os: [ubuntu-18.04] runs-on: ${{ matrix.os }} env: ARG_RUBY_VERSION: ${{ matrix.ruby }} steps: - name: Check out code id: checkout uses: actions/checkout@v2 - name: Generate dotenv id: generate-dotenv run: cp .env.sample .env - name: Cache docker image id: cache-docker-image uses: actions/cache@v1 with: path: ${{ env.IMAGE_CACHE_DIR }} key: ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}-${{ hashFiles('Dockerfile') }} restore-keys: | ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}-Dockerイメージのキャッシュリストアは、公式のキャッシュ処理用actionであるactions/cacheで行います。キャッシュのキーに

${{ hashFiles('Dockerfile') }}を含めているのは、Dockerfileに変更があった際にキャッシュHITさせないようにする事を意図したものです。env: DOCKER_BUILDKIT: 1 COMPOSE_DOCKER_CLI_BUILD: 1 APP_IMAGE_TAG: rails6api-development:0.1.0 APP_IMAGE_CACHE_TAG: rails6api-development-cache # 略 - name: Docker load id: docker-load if: steps.cache-docker-image.outputs.cache-hit == 'true' run: docker image load -i ${IMAGE_CACHE_DIR}/image.tar - name: Docker build id: docker-build run: docker-compose build --build-arg BUILDKIT_INLINE_CACHE=1 base - name: Docker tag and save id: docker-tag-save if: steps.cache-docker-image.outputs.cache-hit != 'true' run: mkdir -p ${IMAGE_CACHE_DIR} && docker image tag ${APP_IMAGE_TAG} ${APP_IMAGE_CACHE_TAG} && docker image save -o ${IMAGE_CACHE_DIR}/image.tar ${APP_IMAGE_CACHE_TAG}上記step群の処理をまとめると、「ビルドされたイメージに

rails6api-development-cacheというタグを付与してtarに保存し、actions/cache のキャッシュ先ディレクトリに image.tar という名前で保存する」という処理を行っています。キャッシュHITの有無で処理の流れは下記のように変わります。

- キャッシュがHITしなかった場合

docker-buildのstepで新規にイメージがビルドされます

- ※

--build-arg BUILDKIT_INLINE_CACHE=trueオプションを指定している理由は、BuildKitが有効化された状態でビルドされたイメージをcache_fromで取り込むには、元のイメージがこのオプション付きでビルドされている必要がある為です- 実際に

cache_fromが指定されているのは、docker-compose.ymlのbaseサービスのbuild設定の箇所(=rails6api-development-cache)- actions/cacheでキャッシュ先として指定した

${IMAGE_CACHE_DIR}をmkdirします- ビルド結果のイメージに別途「キャッシュ用のタグ」を付与します

- =

APP_IMAGE_CACHE_TAG=rails6api-development-cache- 「キャッシュ用のタグ」 =

rails6api-development-cacheを付与したイメージをdocker image saveで保存します。この保存先にactions/cacheでのキャッシュ先ディレクトリを指定します(ファイル名は image.tar)- キャッシュがHITした場合

docker-loadのstepで、キャッシュからリストアされたimage.tarがdocker image loadによって展開されます

- 展開されるイメージには「キャッシュ用のタグ」 =

rails6api-development-cacheが付与されていますdocker-buildのstepでイメージがビルドされますが、先のloadのstepで展開されたイメージによってcache_fromrails6api-development-cacheの指定が効き、このビルドはすぐに終わります- tagとsaveのstepは

if: steps.cache-docker-image.outputs.cache-hit != 'true'の指定によりSKIPされますキャッシュ済のイメージでアプリのCI(テスト)を実行する事で高速化を図る

env: DOCKER_BUILDKIT: 1 COMPOSE_DOCKER_CLI_BUILD: 1 APP_IMAGE_TAG: rails6api-development:0.1.0 APP_IMAGE_CACHE_TAG: rails6api-development-cache # 略 jobs: # 略 test-app: needs: image-cache-or-build # 略 - name: Cache docker image id: cache-docker-image uses: actions/cache@v1 with: path: ${{ env.IMAGE_CACHE_DIR }} key: ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}-${{ hashFiles('Dockerfile') }} restore-keys: | ${{ runner.os }}-${{ env.IMAGE_CACHE_KEY }}-${{ matrix.ruby }}- - name: Docker load id: docker-load if: steps.cache-docker-image.outputs.cache-hit == 'true' run: docker image load -i ${IMAGE_CACHE_DIR}/image.tar - name: Docker compose build id: docker-build run: docker-compose build --build-arg BUILDKIT_INLINE_CACHE=1 base先述のイメージのビルド&キャッシュjobが完了すると、アプリのテストを行う

test-appが起動します。docker-loadのstepでは「キャッシュ用のタグ」 =rails6api-development-cacheが付与されているイメージが展開され、docker-buildのstepでこのイメージをcache_fromによって取り込んでbaseサービスのイメージ(=rails6api-development:0.1.0タグが付与されたイメージ)をビルドします。ufoscout/docker-compose-wait でMySQLコンテナの起動を待つ

- name: Wait middleware services id: wait-middleware run: docker-compose run --rm wait-middleware - name: Confirm docker-compose logs id: confirm-docker-compose-logs run: docker-compose logs dbDockerfileの最後でインストールしてあるufoscout/docker-compose-waitを使って

dbサービスの起動を待ちます。Starting with configuration: - Hosts to be waiting for: [db:3306] - Timeout before failure: 30 seconds - TCP connection timeout before retry: 5 seconds - Sleeping time before checking for hosts availability: 0 seconds - Sleeping time once all hosts are available: 0 seconds - Sleeping time between retries: 1 seconds -------------------------------------------------------- Checking availability of db:3306 Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 not yet available... Host db:3306 is now available! -------------------------------------------------------- docker-compose-wait - Everything's fine, the application can now start! --------------------------------------------------------以前に「GitHub ActionsのCI環境ではこの速さでは起動してくれず、

wait-middlewareの効果が大きくなります」と書きましたが、上記ログがGitHub Actionsのrunnerインスタンス上での実行例で(Host db:3306 not yet available...でsleepを1秒挟んでいます)、ポート3306のLISTENまでに10秒以上掛かっています。このログ例のみならず、何度実行しても平均的に10秒超は掛かっていました。仮にこの所要時間でwaitするstepを挟まない(depends_onを指定するのみ)とすると、MySQL起動前に後続のRailsアプリに関するstepが走ってしまいエラーになるでしょう。余談: MySQLコンテナ起動プロセスのどの処理が遅いのか?