- 投稿日:2020-05-26T23:43:29+09:00

【前編】Mask R-CNNで発生したエラー「UserWarning: An input could not be retrieved. It could be because a worker has died」を解決してみた。

Mask R-CNNのnucleus検出デモを練習中

Deep learning初心者の私が、google colaboratoryを使ってMask R-CNNに試行錯誤している挑戦の続きです。

今回は以下を活用して、細胞の検出に挑戦しています。https://github.com/matterport/Mask_RCNN/tree/master/samples/nucleus

おなじみ、Matterport社のものです。

このデモでは、Mask R-CNNの検出の裏側である、ROIやAnchorなどを表示してくれるとともに、Detectionの際にもStep by stepでやってくれるものです。

初心者にとって、どうやって学習&認識してくれているのか理解することができるので、とても勉強になります。トレーニングのipynbがない

_dataと_modelの2つipynbファイルがあり特につまずくことなくデモを実行できたのですが、detectionで使うweightをトレーニングするipynbがないのです。

そこで、自分で作ってみようと思い、ヒントが隠されているnucleus.pyの中身を見てみました。10~25行目に、トレーニングするために実行するコマンドが書かれていました。

nucleus_train.py#Train a new model starting from ImageNet weights python3 nucleus.py train --dataset=/path/to/dataset --subset=train --weights=imagenet #Train a new model starting from specific weights file python3 nucleus.py train --dataset=/path/to/dataset --subset=train --weights=/path/to/weights.h5 #Resume training a model that you had trained earlier python3 nucleus.py train --dataset=/path/to/dataset --subset=train --weights=last #Generate submission file python3 nucleus.py detect --dataset=/path/to/dataset --subset=train --weights=<last or /path/to/weights.h5>なるほど、0から学習させるためには一番目のコマンドを実行すればいいんですね。

実行してみよう

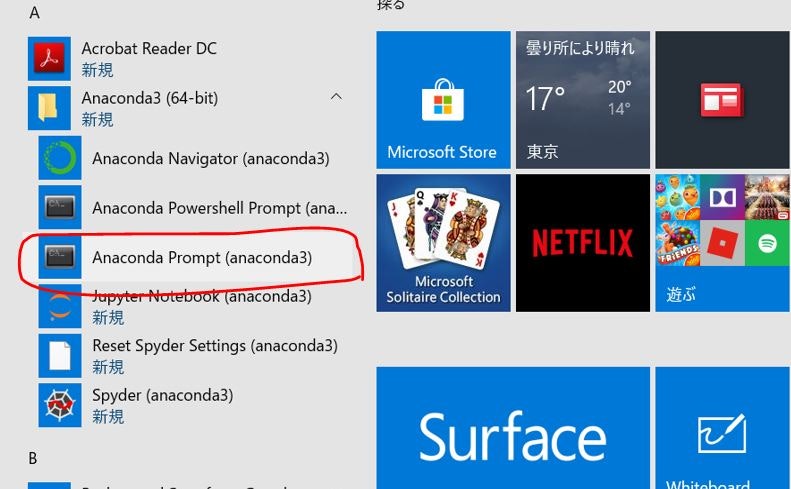

ステップ①:とりあえず実行

--dataset=/path/to/datasetの部分を

nucleus_train.py--dataset=/content/drive/My drive/.../datasetに変更して実行します。

※utils.Dataset.add_imageの中で、

dataset_dir(上記)とsubset_dir(stage1_train)を合体させるので、stage1_trainまで指定する必要はなさそうです。ステップ②:重みDownload

これで実行してみると出力にURLが出現するので、

resnet50_weights_tf_dim_ordering_tf_kernels_notop.h5

をダウンロードします。ステップ③:学習開始

この後、--weights=/path/toの部分を

nucleus_train.py--weights=/content/.../resnet50_weights_tf_dim_ordering_tf_kernels_notop.h5に同様に変更します。

Pathも指定できたので、成功かと思いきや…!?トラブル発生

nucleus_train.pyEpoch 1/20と表示されたまま固まってしまいました。

そこに出ているエラーは、nucleus_train.pyUserWarning: An input could not be retrieved. It could be because a worker has died??なので、そのままgoogleにコピペして調査します。

最初に参考にしたのは以下の記事です。参考記事①

Colabolatoryで UserWarning: An input could not be retrieved. It could be because a worker has died

どうやら、「Colabolatoryのファイルストリームが学習速度に追いついていない。」ことが原因らしい。

google driveから画像を読み込むところがボトルネックになっていったぽい。参考記事②

うーん、pathをcolaboratory内にコピーすればよいことしかわかりませんね…

参考記事③

【秒速で無料GPUを使う】深層学習実践Tips on Colaboratory

nucleus_train.py!cp drive/My Drive/<指定フォルダ>/<指定ファイル等>大きなデータセットなどはzipのままGoogle Driveに保存しておき、Colabを起動都度、Colabローカルに解凍して持ってくると良い。

nucleus_train.py!unzip -q drive/My Drive/<指定フォルダ>/<指定ファイル>.zip-q は解凍時のメッセージを出さないオプション。2GB程度、数千ファイルを含むアーカイブでも、1分程度でGoogle Driveからの取得と解凍が終わる。

なるほど、大きなデータを使う時はcolaboratoryの中にデータを移せばいいんですね!

※この記事はcolaboratoryを活用するのに役立つ情報がわんさかです!参考記事④

ただのコマンド紹介ですが、zipの解凍先はこのように指定できるっぽいです。

nucleus_train.py% unzip dataset.zip -d /content/dataset実装してみた

長くなってしまったので、次の記事で実装例を紹介します!

【

今記事を書いています。乞うご期待!】

【記事書き終わりました。】

- 投稿日:2020-05-26T23:27:39+09:00

【Python】業務効率化ツールを配布するためのexe化手段について検討してみた

やりたいこと

pythonで作った業務効率化ツールを社内で配布したい。メンバーにはPCに疎い人も多いので、exeファイルとして配布する。

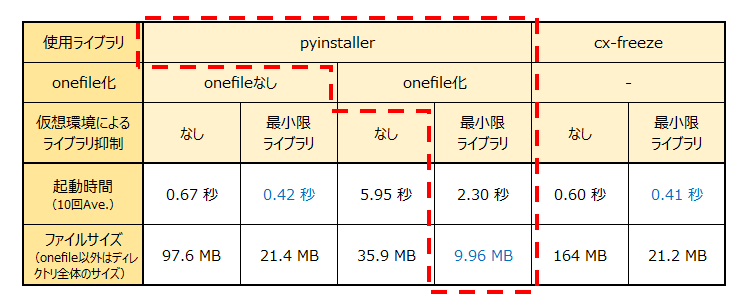

exe化は何通りかのやり方がある。「起動時間」「ファイルサイズ」「配布・導入のし易さ」などの観点で、どの方法でやれば良いか、自分なりに考えてみる。先に結論

pyinstallでonefile化 + 仮想環境で必要最低限のライブラリをインストールした状態でexe化するのが無難と思った。

起動時間が求められる状況では、onefile化は諦めるのも必要かもしれない。環境

Windows10 Home

Python3.8.2(32bit)

Visual Studio Code 1.45.1

PyInstaller3.6勉強・検証した内容

0.検証するコード

1.PyInstallerによるexe化

1-1.onefileにしない(デフォルト)

1-2.onefileにする

2.PyInstaller以外の方法

3.仮想環境下でexe化する0.検証するコード

超簡単なtest.pyを作成し、このファイルを各方法でexe化した。

importしているpyautoguiに特に意味はない(外部ライブラリが一つもないのも寂しいと思ったので)test.pyimport pyautogui print("Hello,World!")尚、起動時間の測定は本稿末尾に記載したツールで測定した。

1.PyInstallerによるexe化

現在一番メジャーと思われるexe化の手段。標準ライブラリではないのでpipでインストールする。

ターミナルから> pip install pyinstallerでインストール。

その後、ターミナルから> pyinstaller <変換するファイル.py> <-オプション>を実行すると、exe化が始まる。

オプションで後述するワンファイル化や、exeファイルの名前の変更、起動したときにコンソール(黒い画面)を表示させなくする等を設定できる。オプションの「-」(ハイフン)は一本だったり二本だったりするので注意。> pyinstaller test.py --name test2 --noconsole --onefile

~INFO: Building EXE from EXE-00.toc completed successfully.と表示されたら完了。exe化したファイルはカレントディレクトリの中の「dist」というフォルダ内に生成される。オプションで名前を指定しなかった場合、変換するファイル名.exeのファイルが生成される。1-1.onefileにしない(デフォルト)

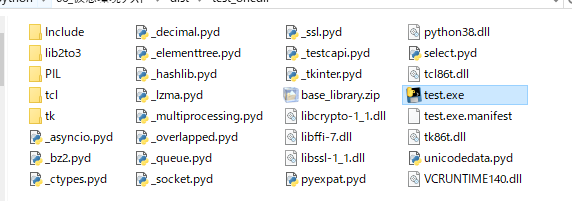

オプションに--onefileを指定しない(=デフォルト)と、distフォルダにファイル名のフォルダが生成されており、その中にexeファイルが格納されている。メリットは起動時間の早さ。後述のワンファイル化する方法だと起動に5秒以上かかってしまうのに対し、ワンファイル化しないと1秒未満で起動できる。ただし、ディレクトリ内はこんな感じ。

うちの職場の場合、このフォルダを「この中にある〇〇〇.exeをクリックして起動してくださいね」と言って配布しても、しばらくして使われなくなることが容易に想像できる。(ショートカットを作成してもらえればワンチャンあるかも)1-2.onefileにする

やはりツールは配布したあとにシンプルに使ってもらうため、一つのファイルにまとめたい。

そのやり方は簡単。pyinstallerを実行する際に--onefile(もしくは-F)のオプションを追加するだけ。これでdistフォルダにexeのみの単一のファイルが追加されるようになる。

デメリットは起動時間。何も対策をしないと、test.pyみたいな超単純なコードでも起動に5秒以上かかってしまうプログラムとなる。2.PyInstaller以外の方法

Windows対応だと「cx-Freeze」「py2ex」が有名っぽい。

py2exはPython3.4までしか対応していないとのこと。(一応、直接GithubからダウンロードすればPython3.7まで対応できるらしい。トライしてみたけどPythonのバージョン切替が良くわからなくて諦めた)

ということでcx-Freezeの方を試してみた。導入及びexe化の仕方は下記のサイトが参考になったので割愛。

cx_FreezeでPythonをexeにしてみた

変換するスクリプトとは別にsetup.pyという設定用ファイルを作成する必要あるため、ひと手間かかるのが気になる。(py2exも同様らしい)

起動時間はそこそこ早い(0.6秒程度)が、onefile化できないみたいで、ファイルサイズも大して変わらないので、PyInstallerと比較してメリットは少ないと感じた。3.仮想環境下でexe化する

PyInstaller + onefile化でtest.pyを変換すると、ただ「Hello,World!」と表示するだけのファイルが36M程度になった。これはまだマシな方で、環境によっては100MBを超すことも多々あるらしい。

どうやらPyInstallerはファイルが肥大化しやすく、その原因は、使用しているPythonにインストールされているライブラリ等をすべてパッケージングしてしまうことにある模様。

そこで、対策として何もインストールされていないまっさらな仮想環境を構築し、そこに必要最低限のライブラリをいれてpyinstallerでexe化してあげればよい、と以下の記事で勉強させていただいた。

【悲報】PyInstallerさん、300MBのexeファイルを吐き出すようになる仮想環境構築について、自分なりにやり方を整理したので、備忘録も兼ねて記しておく。

3-1.仮想環境を作成する

総合ターミナルから「venv」コマンドを実行して仮想環境を構築する(Vertial ENVironmentの略?)

> py -m venv <任意の仮想環境名(ここではpyautogui_only)>⇒ カレントディレクトリに任意の仮想環境名のフォルダが作成される

3-2.作成した仮想環境をアクティブにする。

先ほど作成されたフォルダの「Scripts」フォルダから「Activate.ps1」を右クリック ⇒ パスとしてコピー ⇒ 総合ターミナルに貼り付け ⇒前後の"(ダブルクォーテーション)を削除 ⇒ ENTERで実行(cdで移動してして実行でもOK)

> C:\Users\aaa\Desktop\python\pyautogui_only\Scripts\Activate.ps1ここで「このシステムではスクリプトの実行が無効になっているため~」というエラーが出る人は、多分セキュリティの設定上スクリプトが実行できない状態になっている。なので、総合ターミナル上でまず以下コマンドを実行する。

> Set-ExecutionPolicy RemoteSigned -Scope Processその後、もう一度Activate.ps1を実行すると多分アクティブ化できるはず。

この設定はターミナルを立ち下げるたびに再度設定が必要。参考ページ↓にはVSCode恒久的に設定を変えるやり方も書いてあった。

Windows版VisualStudioCodeで、スムーズvenvを使うための設定まとめ

アクティブ化に成功するとハイパーターミナルのカレントディレクトリの左側に仮想環境名が表示される。(pyautogui_only) PS C:Users\~\ > _3-3.pipコマンドで必要なライブラリのみをインストール。

今回のtest.pyの場合はpyautoguiのみインストール。PyInstallerも忘れずインストールしておく。

(ちなみになぜか最新のpyautoguiのインストールでエラー出る場合はこちらも見てみてください)3-4.PyInstallerを実行

仮想環境でないときと同じようにでOK。

(pyautogui_only) PS C:Users\~\ > pyinstaller test.py --onefile⇒ distフォルダ内にexeファイルが出力される。

(ちなみに仮想環境を抜け出すには総合ターミナルでdeactivateコマンドを実行する)結果、自分の場合、そのままだと36MB程度だったファイルサイズが10MB程度まで抑制できた。

起動時間も6秒程度かかっていたのが2.3秒程度まで短縮できた。まとめ

今回検証した数値を並べると以下のような感じ。

前述したとおり、業務改善ツールの配布目的だったらPyInstaller + onefile化 + 仮想環境での最低限ライブラリインストールで良いかな、と思います。(数秒程度の起動なら、毎回でもそこまで苦にはならないはず)

いちいち仮想環境作るのはやや面倒ですが、exe化はそこまで頻発する作業でもなさそうですし。

もちろん、この結果はtest.pyみたいな超簡単なプログラムのケース。使用する外部ライブラリが増えてきたりすると状況が変わる可能性もあるので、都度判断が必要ですね。おまけ:起動時間を測定するため作ったプログラム

import time import subprocess import sys import csv import pyautogui import os if len(sys.argv) >= 2: start_time = time.time() subprocess.run(sys.argv[1]) # ←ドラッグ&ドロップしたファイルのパスを受け取り、実行 end_time = time.time() process_time = end_time - start_time pyautogui.alert(str(sys.argv[1]) + " " + str(process_time)) # ただの結果表示 # 結果をこのファイルと同じディレクトリ内にcsvで出力 file_name = os.path.join(os.path.dirname(sys.argv[0]), "check_time.csv") with open(file_name, "a", newline="") as fo: csv_file = csv.writer(fo) csv_file.writerow([sys.argv[1], process_time])↑これをexeファイルにして、ドラッグ&ドロップでプログラムを起動し、終了するまでかかった時間を測定⇒出力。

- 投稿日:2020-05-26T22:58:21+09:00

GAE & GCS & Django で image URL が Blank な件

概要

Django を動かしている インフラを GKE から GAE に載せ替えた時に発狂したメモ

django-storages というモジュールを使って、imageField 経由でGCSへのアップロード・URLの取得を行っていた

https://django-storages.readthedocs.io/en/latest/backends/gcloud.html?highlight=GS_DEFAULT_ACL#settingsしかし、GAEに移行したら imageField が空白で返ってくる様になった

upload は上手くいくし、Django を localhost や GKE で動かすときは上手くいく結論

URLの有効期間とかが不要なのであれば

settings に下記を追記すれば良いだけDEFAULT_FILE_STORAGE = 'storages.backends.gcloud.GoogleCloudStorage' GS_BUCKET_NAME = 'yourbacketname' GS_DEFAULT_ACL = 'publicRead' <= 追加追跡経路 / 原因

GAE はスタックドライバーにエラーログも吐かなかった

ステータス自体は 200だったからだ認証系は、GAEなのでデフォルトサービスアカウントにストレージの管理者権限を付与して 問題無いと思っていた

でも動かない仕方がないので django-storage のソースを追った

python3.6/site-packages/storages/backends/gcloud.pydef url(self, name): """ Return public url or a signed url for the Blob. This DOES NOT check for existance of Blob - that makes codes too slow for many use cases. """ name = self._normalize_name(clean_name(name)) blob = self.bucket.blob(self._encode_name(name)) if not self.custom_endpoint and self.default_acl == 'publicRead': return blob.public_url elif self.default_acl == 'publicRead': return '{storage_base_url}/{quoted_name}'.format( storage_base_url=self.custom_endpoint, quoted_name=_quote(name, safe=b"/~"), ) elif not self.custom_endpoint: return blob.generate_signed_url(self.expiration) else: return blob.generate_signed_url( expiration=self.expiration, api_access_endpoint=self.custom_endpoint, )GAEのデバック機能を使用して、デプロイ&ブラウザでのチマチマデバッグを繰り返したら

blob.generate_signed_url(self.expiration)この関数が悪人らしい

実際はエラーを吐いていたが、握り潰されていたのでGAEデバッグで try except でやっと原因が判明

"you need a private key to sign credentials.the credentials you are currently using <class 'google.auth.compute_engine.credentials.Credentials'> just contains a token.認証系のエラーでした

※ ちなみに、self に入ってる _service_account_email はキッチリGAEのやつでした

めんどいので、URLに認証情報なんていらないということで

self.default_acl == 'publicRead': の分岐に入れるために、settings に定数を追加した感じです疲れた・・・

後で代表に聞いたら

「バケットの作り直しでもイケるで」って言われた泣いた

- 投稿日:2020-05-26T22:40:40+09:00

競馬予想 機械学習(LightGBM)で回収率100%超えた話

はじめに

最近データ分析にはまっています。

データ分析コンペのKaggleをやっていて、私がよく思うのは「売上予測?もっと面白いテーマはないのかい?」です。

そんなわけで、勉強も兼ねて一から競馬予測モデルを作ることにしました。上手くいけば金儲けもできるし、競馬好きの私にとっては最高の分析テーマです。

ほぼ初心者ですが、結果として回収率が安定して100%を超えるようなモデルが作成できたので、この記事では、競馬モデル作成までのおおざっぱな流れと、シュミレーション結果の詳細について記載していきます。考え方でおかしなところがあればご指導お願いします。

条件設定

出走馬の走破タイムを予測し、最も速いタイムの馬に単勝掛けします。

巷では、1着の馬の的中率を挙げるようなモデルが多かったですが、回収率が思うように伸びてないようなものが多かったように思います。それならば、純粋にタイムを予測してから賭けると、いい感じになるかも?(暴論)と思い、この設定にしました。

本当は他にも理由がありまして.....

競馬では、人気馬は能力値以上に多くの人が賭けてしまうそうです。(参考:人気馬を軸にしたら勝てない理論)

つまり、1着的中率を追求するより、オッズにも目を向けて予想することで回収率を上げれるのかもしれません。

ただ、私は余裕をもって馬券を買いたいので、レース直前に確定するオッズを特徴量に組み込みたくないのです。どうしようかな...

競馬は様々な要因が絡むので、純粋に走破タイムを予測するのは困難です。困難だからこそ、人が賭けないような期待値の高い馬を予測してくれるのではないか?(暴論)。よし、走破タイムで行こう。

学習対象とシュミレーション対象

京都に住んでいるので、京都競馬のみを対象としました。データは、2009年から2019年までのほぼ全レース(データの前処理の項で説明します)とします。

それらを学習用データとテスト用データに分けて、テストデータに対してシュミレーションを行いました。合計で7年分のシュミレーションです。以下はデータ分割の内容です。

学習用データ テスト用データ 2009~2018 2019 2009~2017 2018 2009~2016 2017 2009~2015 2016 2009~2014 2015 2009~2013 2014 2009~2012 2013 万が一リークする場合も考え、学習データはテストデータより前の年にしています。

扱った特徴量の詳細は以下で説明します。

モデル作成までの流れ

- データの取得(webスクレイピング)

- データの前処理

- モデル作成

1. データの取得

お金を払えばデータを簡単に取得できそうですが、勉強も兼ねてwebスクレイピングでデータを取得しました。

まずはHTML・CSSをProgateで簡単に勉強です。最低限知識がないとどこに欲しいデータがあるかわからなかったからです。

WEBスクレイピングに関しては、以下の記事を参考に作成しました。正直ここが一番大変だった気がします。(例外処理が多すぎる!)

スクレイピング対象のサイトは https://www.netkeiba.com/ です。

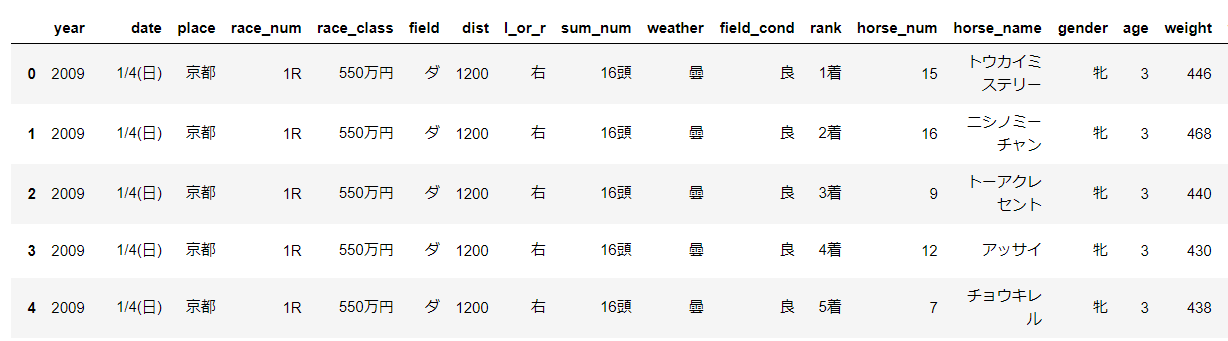

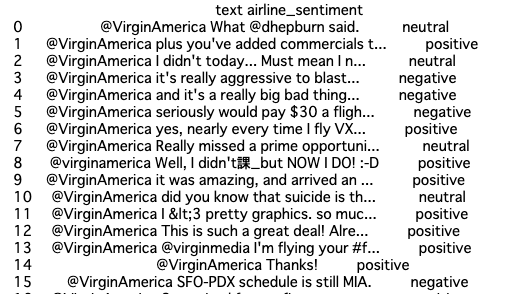

以下は実際にスクレイピングして得たデータです。コードは付録に載せています。

取得したデータは以下の通りです

feature 説明 feature 説明 race_num 第何レース field 芝かダートか dist 距離 l_or_r 右回りor左回り sum_num 頭数 weather 天候 field_cond 馬場状態 rank 着順 horse_num 馬番 horse_name 馬名 gender 性別 age 年齢 weight 馬の体重 weight_c 騎手の体重 time 走破タイム sum_score 通算成績 odds 単勝オッズ popu 人気 +で前走3レース分のデータを得ています。

この中で、走破タイム、着順、オッズ、人気の特徴量は学習データとして使っていません。

また、前走3レース分ない馬については情報を削除しています。しかし、各レースで一頭でも情報が残っていれば、その中で一番早い馬を予測します。当然、消し去ったデータに一着馬がいれば予想は外れることになります。

一年あたり大体450レース分のデータが残ります。(ほぼ全レース)

2. データの前処理

得られたデータを機械学習モデルに入れられるように変換します。といっても、カテゴリ変数をラベルエンコーディングしたり、文字型を数値型に変化しただけです。

今回扱うモデルのアルゴリズム木モデルの一種なので、標準化などは行っていません。

また、取得した特徴量を使って、新たな特徴量を何個か作っています。(距離とタイムから速さなど)

3. モデル作成

勾配ブースティング決定木アルゴリズムのLightGBMライブラリを使用して実装しました。Kaggleなんかで最近よく使われているあれです。

以下は実装コードです。

lgb_train = lgb.Dataset(X_train, y_train) lgb_eval = lgb.Dataset(X_valid, y_valid, reference=lgb_train) params = {'objective': 'regression', 'metric': 'rmse', } model = lgb.train( params, lgb_train, valid_sets=[lgb_train, lgb_eval], verbose_eval=10, num_boost_round=1000, early_stopping_rounds=10)御覧の通り何の工夫も行っていません(笑)

Optunaなどを使ってパラメータチューニングを行ってみたのですが、いかんせん評価関数と回収率は別ものなので、回収率向上にはそれほどつながりませんでした。

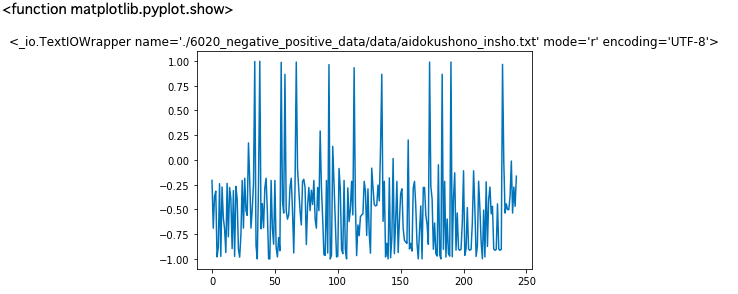

シュミレーション

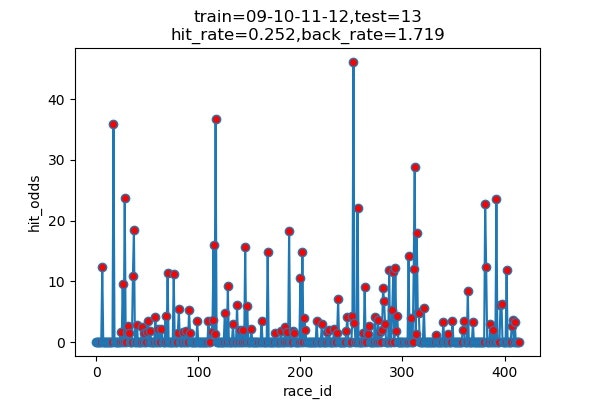

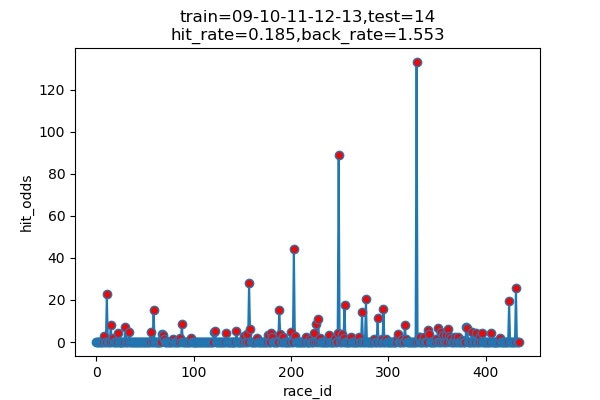

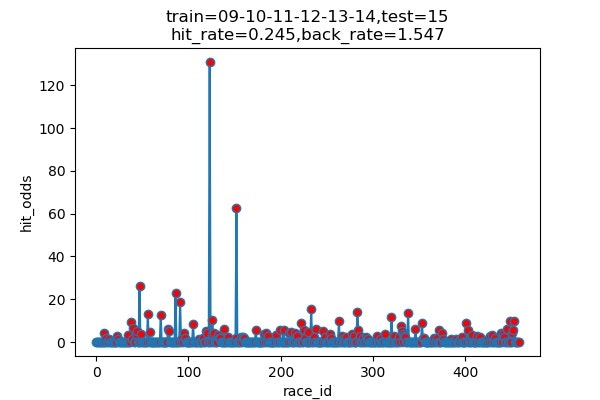

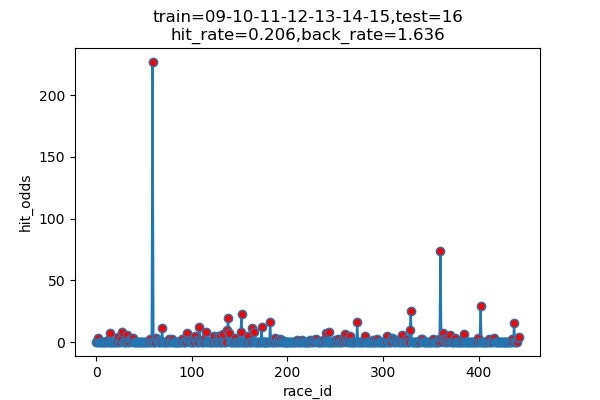

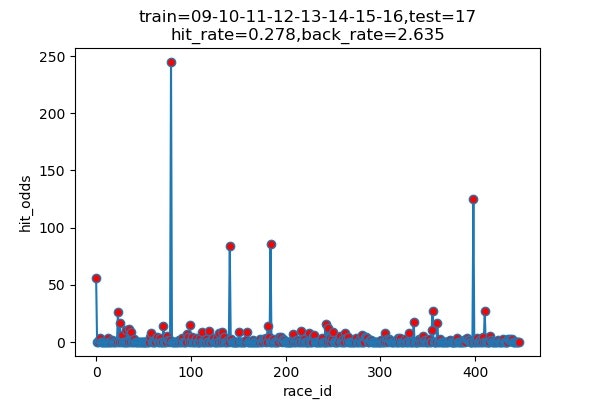

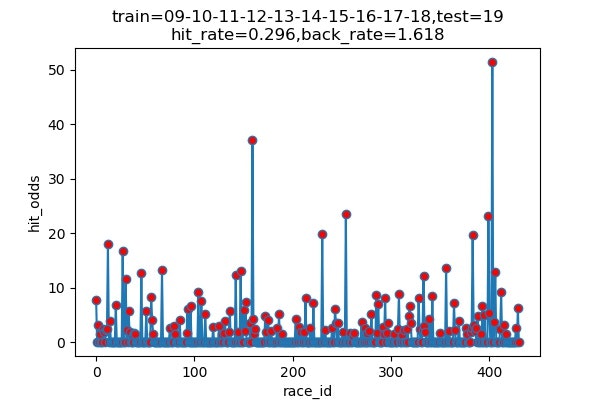

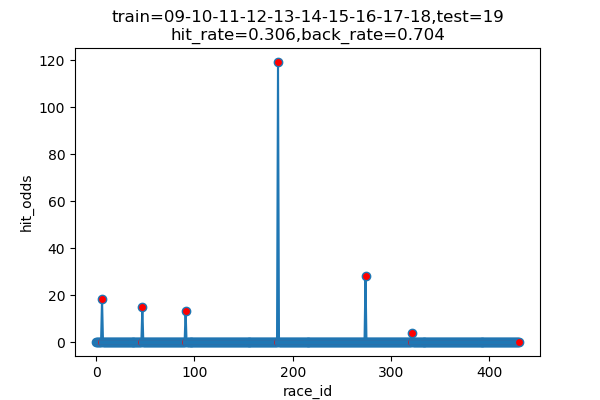

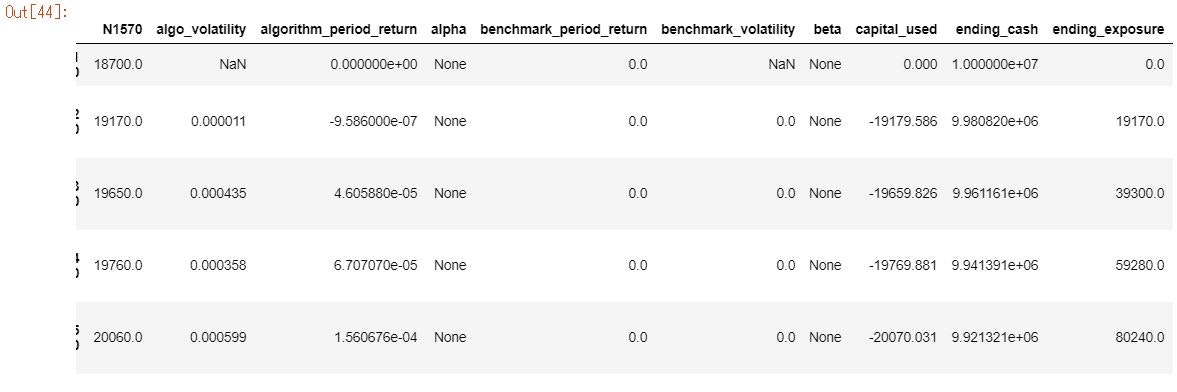

以下は7年分のシュミレーション結果です

横軸 : 何レース目か

縦軸 : 的中した場合の単勝オッズ(外れた場合は0)

hit_rate : 的中率

back_rate : 回収率

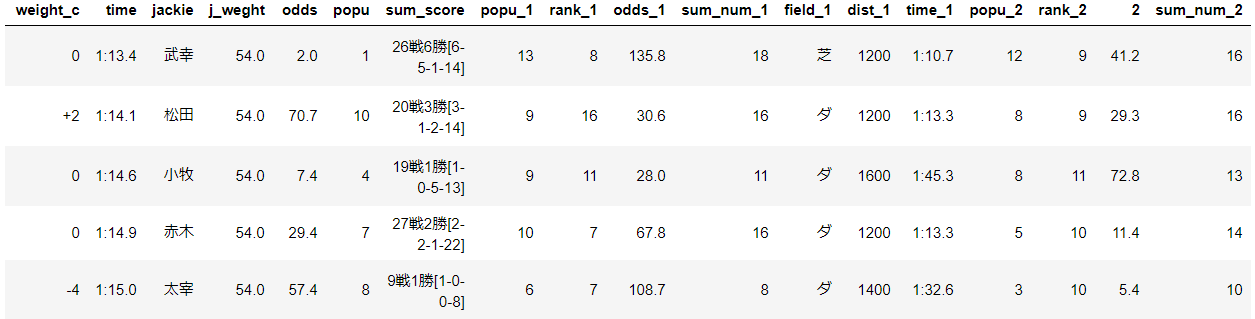

titleのtrainとtestはそれぞれに使ったデータの期間を表しています。(09は2009年)以下に結果をまとめます

シュミレーション年度 的中回数 的中率 回収率 2013 116/460 25.2% 171.9% 2014 89/489 18.5% 155.3% 2015 120/489 24.5% 154.7% 2016 101/491 20.6% 163.6% 2017 131/472 27.8% 263.5% 2018 145/451 32.2% 191.8% 2019 136/459 29.6% 161.7% 平均 ------ 25.5% 180.4% 上出来すぎです。

的中率はまあまあですが、驚いたのは、オッズの高い馬をちょくちょく当ててきていることです。

2017年には、250倍の馬当ててるし!

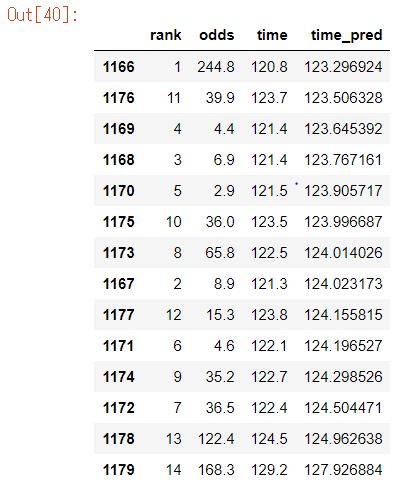

気になるので、中身を見てみましょう

以下はその日のレースの内容です。(time_pred順にsortしています)マジで当ててる。

何か間違っているのではないかと怖くなってきました。そもそもこんな簡単に100%を超えてしまっていいのでしょうか。

こういう時は何を調べたら、正しいといえるのでしょうか.....

リアルでやってみるしかないですね!

以下は一応探ってみたことです。

・当日に使える特徴量だけを使っているか

・回収率の計算式は合っているか

・ネットの情報と齟齬はないか?

・予想タイムが最も早い者を選択できているか

・作成モデルを様々な方向から遊んでみる

モデルで遊んでみた

折角なのでいろいろ検証してみます。

1 一番遅いと予測した馬をかけてみる

6回だけ当てています。

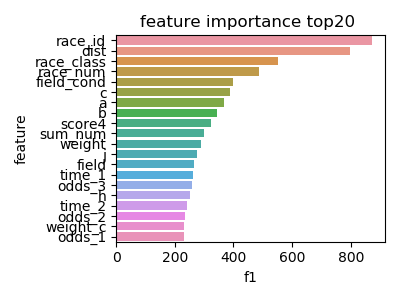

2 特徴量の重要度

以下はlightGBMのfeature-importannces(2019)です。

a,b,cはそれぞれ前走、前々走、前前々走の馬の速さ(dist/time)です。タイムを予測しているので

dist(レース距離)が重要なのはわかりますが、race_id(その年の何レース目か)が重要なのははて?季節をタイムを予測するのに重要なのでしょうか。

他にも

race_cond(馬場状態),race_num(その日第何レース)など、環境が大きな重要度を占めています。3 n番人気をかけ続けるとどうなるか?

作成したモデルとは一切関係ありません(笑)

以下は2019年度の結果です

n番人気 的中率 回収率 1番人気 30.9% 71.1% 2番人気 17.3% 77.2% 3番人気 15.3% 90.3% 4番人気 10.1% 81.3% 5番人気 8.4% 100.5% 6番人気 6.2% 92.4% 7番人気 3.2% 64.2% 8番人気 2.4% 52.1% 9番人気 1.5% 48.2% 10番人気 1.3% 59.1% 11番人気 1.5% 127.6% 12番人気 1.3% 113.9% 13番人気 1.5% 138.6% 14番人気 0.4% 77.8% とても面白い結果です

回収率を狙うなら不人気馬を買い続けるのもありですね。

ほとんど当たらないので見ていても楽しくなさそうですが(笑)面白いので2013~2019年の平均で見てみました。

n番人気 的中率 回収率 1番人気 31.7% 73.4% 2番人気 20.0% 83.7% 3番人気 13.2% 80.2% 4番人気 9.9% 81.9% 5番人気 7.8% 89.1% 6番人気 5.5% 89.8% 7番人気 4.2% 86.0% 8番人気 2.4% 64.8% 9番人気 2.1% 64.8% 10番人気 1.7% 80.9% 11番人気 1.1% 98.2% 12番人気 1.0% 69.4% 13番人気 1.1% 113.2% 14番人気 0.2% 35.4% ※取得できたデータのみで行った検証なので注意

面白い

まとめ

ほぼ工夫無しで、回収率100%超えられる

lightGBMすごい付録

汚いコードですがご了承ください。

・スクレイピング(レース情報と各馬のURLの取得)

def url_to_soup(url): time.sleep(1) html = requests.get(url) html.encoding = 'EUC-JP' return BeautifulSoup(html.text, 'html.parser') def race_info_df(url): df1 = pd.DataFrame() HorseLink = [] try: # year = '2018' # url = 'https://race.sp.netkeiba.com/?pid=race_result&race_id=201108030409&rf=rs' soup = url_to_soup(url) if soup.find_all('li',class_='NoData') != []: return df1,HorseLink else: race_cols = ['year', 'date', 'place', 'race_num' ,'race_class', 'field', 'dist', 'l_or_r',\ 'sum_num','weather', 'field_cond', 'rank', 'horse_num', 'horse_name', 'gender', 'age',\ 'weight', 'weight_c', 'time', 'jackie', 'j_weght', 'odds', 'popu'] # 共通項目 # # Year = year Date = soup.find_all('div', class_='Change_Btn Day')[0].text.split()[0] Place = soup.find_all('div', class_="Change_Btn Course")[0].text.split()[0] RaceClass = soup.find_all('div', class_="RaceDetail fc")[0].text.split()[0][-6:].replace('、','') RaceNum = soup.find('span', id= re.compile("kaisaiDate")).text RaceData = soup.find_all('dd', class_="Race_Data")[0].contents Field = RaceData[2].text[0] Dist = RaceData[2].text[1:5] l_index = RaceData[3].find('(') r_index = RaceData[3].find(')') LOrR = RaceData[3][l_index+1:r_index] RD = RaceData[3][r_index+1:] SumNum = RD.split()[0] Weather = RD.split()[1] FieldCond = soup.find_all('span',class_= re.compile("Item"))[0].text # Not 共通 # HorseLink = [] for m in range(int(SumNum[:-1])): HN = soup.find_all('dt',class_='Horse_Name')[m].contents[1].text HL = soup.find_all('dt',class_='Horse_Name')[m].contents[1].get('href') HorseLink.append(HL if HN!='' else soup.find_all('dt',class_='Horse_Name')[m].contents[3].get('href')) HorseName = [] for m in range(int(SumNum[:-1])): HN = soup.find_all('dt',class_='Horse_Name')[m].contents[1].text HorseName.append(HN if HN!='' else soup.find_all('dt',class_='Horse_Name')[m].contents[3].text) # print(soup.find_all('dt',class_='Horse_Name')[m].contents[3]) Rank = [soup.find_all('div',class_='Rank')[m].text for m in range(int(SumNum[:-1]))] # ここから得られる情報も獲得 HorseNum = [soup.find_all('td', class_ = re.compile('Num Waku'))[m].text.strip() for m in range(1,int(SumNum[:-1])*2+1,2)] Detail_Left = soup.find_all('span',class_='Detail_Left') Gender = [Detail_Left[m].text.split()[0][0] for m in range(int(SumNum[:-1]))] Age = [Detail_Left[m].text.split()[0][1] for m in range(int(SumNum[:-1]))] Weight = [Detail_Left[m].text.split()[1][0:3] for m in range(int(SumNum[:-1]))] WeightC = [Detail_Left[m].text.split()[1][3:].replace('(','').replace(')','') for m in range(int(SumNum[:-1]))] Time = [soup.find_all('td', class_="Time")[m].contents[1].text.split('\n')[1] for m in range(int(SumNum[:-1]))] Detail_Right = soup.find_all('span',class_='Detail_Right') Jackie = [Detail_Right[m].text.split()[0] for m in range(int(SumNum[:-1]))] JWeight = [Detail_Right[m].text.split()[1].replace('(','').replace(')','')for m in range(int(SumNum[:-1]))] Odds = [soup.find_all('td', class_="Odds")[m].contents[1].text.split('\n')[1][:-1] for m in range(int(SumNum[:-1]))] Popu = [soup.find_all('td', class_="Odds")[m].contents[1].text.split('\n')[2][:-2] for m in range(int(SumNum[:-1]))] Year = [year for a in range(int(SumNum[:-1]))] RaceCols = [Year, Date, Place, RaceNum ,RaceClass, Field, Dist, LOrR,\ SumNum,Weather, FieldCond, Rank, HorseNum, HorseName, Gender, Age,\ Weight, WeightC, Time, Jackie, JWeight, Odds, Popu] for race_col,RaceCol in zip(race_cols,RaceCols): df1[race_col] = RaceCol return df1,HorseLink except: return df1,HorseLink・スクレイピング(各馬の今までのレース情報)

def horse_info_df(HorseLink, df1): df2 = pd.DataFrame() # print(HorseLink) for n,url2 in enumerate(HorseLink): try: soup2 = url_to_soup(url2) horse_cols = ['sum_score',\ 'popu_1','rank_1','odds_1','sum_num_1','field_1','dist_1','time_1',\ 'popu_2','rank_2','2','sum_num_2','field_2','dist2','time_2',\ 'popu_3','rank_3','odds_3','sum_num_3','field_3','dist_3','time_3'] sec = 1 ya = soup2.find_all('section',class_="RaceResults Sire") #ya = soup.find_all('div',class_="Title_Sec") if ya !=[]: sec = 2 tbody1 = soup2.find_all('tbody')[sec] SomeScore = tbody1.find_all('td')[0].text # print(SomeScore) tbody3 = soup2.find_all('tbody')[2+sec] HorseCols = [SomeScore] for late in range(1,4): HorseCols.append(tbody3.contents[late].find_all('td')[2].text) # Popu HorseCols.append(tbody3.contents[late].find_all('td')[3].text) # Rank HorseCols.append(tbody3.contents[late].find_all('td')[6].text) # Odds HorseCols.append(tbody3.contents[late].find_all('td')[7].text) # SumNum HorseCols.append(tbody3.contents[late].find_all('td')[10].text[0]) # Field HorseCols.append(tbody3.contents[late].find_all('td')[10].text[1:5]) # Dist HorseCols.append(tbody3.contents[late].find_all('td')[14].text) # Time dfplus = pd.DataFrame([HorseCols], columns=horse_cols) dfplus['horse_name'] = df1['horse_name'][n] df2 = pd.concat([df2,dfplus]) except: pass return df2

- 投稿日:2020-05-26T22:23:20+09:00

Brian2で神経活動をシミュレーションする

神経活動をコンピュータ上でシミュレーションする研究は以前から行われています。

シミュレータとしてはイェール大学のNEURONが有名ですが、他にも様々なソフトがあります。今回は、去年(2019年)にeLifeで論文発表されたBrian2というソフトを使ってみます。

*間違えやすいですが、名前はBrain(脳)ではなくてBrian(ブライアン)ですね。ホームページ:https://briansimulator.org/

GitHub:https://github.com/brian-team/brian2

論文:https://elifesciences.org/articles/47314

開発元はフランスのソルボンヌ大学などです。インストール

環境は

Ubuntu 16.04

Anaconda

Python 3.6

です。インストールはcondaでもpipでも出来るようです。

pip install brian2これでインストールできました。

バージョンはbrian2-2.3.0.2でした。次項からドキュメントのチュートリアルを参考にしながら基本的なところをやってみます。

動かしてみる

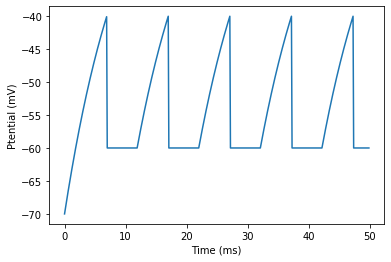

まずは単純な膜電位シミュレーションをやってみます。

インポートします。

(この項ではどれがモジュールかを分かりやすくするために、あえてマニュアル通りのfrom brian2 import *ではなく普通にインポートします。)import brian2Brian2には物理単位がモジュールになっていて、

Hzやmsなどをそのまま定義することができます。

これを使うことで、パラメータや定数を簡潔に記述できます。

また、計算時に物理単位が揃わないとエラーになるようになっているので設定ミスを防ぐことができます。v0 = -10 * brian2.mV tau = 10 * brian2.msシミュレーションを始めるときにはまず

start_scope()を入れます。brian2.start_scope()微分方程式(膜電位の変化を定義する)はString型で定義するようです。

eqs = 'dv/dt = (v0-v)/tau : volt (unless refractory)'上記のvoltは変数の物理単位です。SI単位で表します。

ここでは膜電位が変数になります。

(unless refractory)は不応期を使う場合に必要です。神経細胞は

NeuronGroupモジュールで定義します。G = brian2.NeuronGroup(1, eqs, threshold='v > -40*mV', reset='v = -60*mV', refractory=5*brian2.ms, method='exact')第一引数は神経細胞の数です。今回は1個で設定しました。

第二引数は膜電位の微分方程式です。

他の引数は

thresholdはスパイクになる閾値電位

resetはスパイク後のリセット電位

refractoryは不応期

methodは数値計算の方法

を設定しています。膜電位の初期値を設定します。

G.v = -70 * brian2.mV

StateMonitorによってモニタリングができます。M = brian2.StateMonitor(G, 'v', record=True)シミュレーションは

run(<時間>)によって開始されます。brian2.run(50*brian2.ms)これでシミュレーションできました。

結果をプロットします。

brian2.plot(M.t/brian2.ms, M.v[0]/brian2.mV) brian2.xlabel('Time (ms)') brian2.ylabel('Ptential (mV)');この結果はLIFモデルのニューロンのスパイクをシミュレーションした結果になります。(ピーク電位がありませんが。)

これでシミュレーションの流れが分かりました。

発展として、

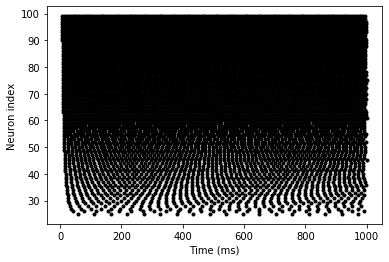

xi(標準正規分布の確率変数)を使うことで、ノイズを含んだ確率微分方程式を扱うこともできるようです。複数の神経細胞のスパイクシミュレーション

次に複数の神経細胞のスパイクをシミュレーションします。

今回は各細胞に異なる入力電位(I)を与えてみます。インポートからやっていきます。

from brian2 import * start_scope() N = 100 #細胞の数 tau = 10*ms #膜時定数 v0 = -50*mV #静止膜電位 eqs = ''' dv/dt = (v0-v+I)/tau : volt (unless refractory) I : volt ''' G = NeuronGroup(N, eqs, threshold='v>-40*mV', reset='v=-60*mV', refractory=1*ms, method='exact') G.v = -70*mV膜電位変化ではなくスパイクのみを見たいときは

SpikeMonitorを使います。M = SpikeMonitor(G)各細胞に異なる入力を定義します。

I_max = 40*mV G.I = 'i*I_max/(N-1)'iは細胞のインデックスになります。これで異なる入力を定義できました。

runします。

duration = 1000*ms run(duration)ラスタープロットを作成します。

plot(M.t/ms, M.i, '.k') xlabel('Time (ms)') ylabel('Neuron index');細胞のインデックスが上がるごとに入力電位が上がるので、スパイクが多くなりました。

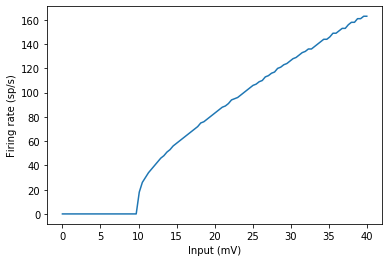

よく見るF-Iカーブも作ってみます。

plot(G.I/mV, M.count/duration) xlabel('Input (mV)') ylabel('Firing rate (sp/s)');神経回路をシミュレーションするには

詳細は割愛しますが、神経回路のシミュレーションも簡単に出来るようです。

シナプスは

Synapsesモジュールで定義できます。

connectメソッドで細胞の結合が行われます。(どの細胞からどの細胞へつなげるか)シナプスの強度に微分方程式を定義することもできて、STDPモデルも作れるようです。

他にも

Networkでネットワークの定義ができたりするようです。感想

シミュレーションのための機能が充実していて、使いやすいと思いました。

ドキュメントには他にも様々な例が載っています。

https://brian2.readthedocs.io/en/stable/examples/index.html

コンパートメントモデルの例もありました。

これらも試してみたいですね。*追記

今年の1月にBrian2GeNNというものが発表されていました。

https://www.nature.com/articles/s41598-019-54957-7

これでGPUも活用できるようになったみたいです。

- 投稿日:2020-05-26T22:23:20+09:00

Brian2で神経活動シミュレーション

神経活動をコンピュータ上でシミュレーションする研究は以前から行われていています。

シミュレータとしてはYale大学のNEURONが有名ですが、他にも様々なソフトがあります。今回は、去年(2019年)にeLifeで論文発表されたBrian2というソフトを使ってみます。

*「Br ai n2」ではなくて「Br ia n2」です。ホームページ:https://briansimulator.org/

GitHub:https://github.com/brian-team/brian2

論文:https://elifesciences.org/articles/47314

開発元はフランスのソルボンヌ大学などです。インストール

環境は

Ubuntu 16.04

Anaconda

Python 3.6

です。インストールはcondaでもpipでも出来るようです。

pip install brian2これでインストールできました。

バージョンはbrian2-2.3.0.2でした。次項からドキュメントのチュートリアルを参考にしながら基本的なところをやってみます。

動かしてみる

まずは単純な膜電位シミュレーションをやってみます。

インポートします。

(この項ではどれがモジュールかを分かりやすくするために、あえてマニュアル通りのfrom brian2 import *ではなく普通にインポートします。)import brian2Brian2には物理単位がモジュールになっていて、

Hzやmsなどをそのまま定義することができます。

これを使うことで、パラメータや定数を簡潔に記述できます。

また、計算時に物理単位が揃わないとエラーになるようになっているので設定ミスを防ぐことができます。v0 = -10 * brian2.mV tau = 10 * brian2.msシミュレーションを始めるときにはまず

start_scope()を入れます。brian2.start_scope()微分方程式(膜電位の変化を定義する)はString型で定義するようです。

eqs = 'dv/dt = (v0-v)/tau : volt (unless refractory)'上記のvoltは変数の物理単位です。SI単位で表します。

ここでは膜電位が変数になります。

(unless refractory)は不応期を使う場合に必要です。神経細胞は

NeuronGroupモジュールで定義します。G = brian2.NeuronGroup(1, eqs, threshold='v > -40*mV', reset='v = -60*mV', refractory=5*brian2.ms, method='exact')第一引数は神経細胞の数です。今回は1個で設定しました。

第二引数は膜電位の微分方程式です。

他の引数は

thresholdはスパイクになる閾値電位

resetはスパイク後のリセット電位

refractoryは不応期

methodは数値計算の方法

を設定しています。膜電位の初期値を設定します。

G.v = -70 * brian2.mV

StateMonitorによってモニタリングができます。M = brian2.StateMonitor(G, 'v', record=True)シミュレーションは

run(<時間>)によって開始されます。brian2.run(50*brian2.ms)これでシミュレーションできました。

結果をプロットします。

brian2.plot(M.t/brian2.ms, M.v[0]/brian2.mV) brian2.xlabel('Time (ms)') brian2.ylabel('Ptential (mV)');この結果はLIFモデルのニューロンのスパイクをシミュレーションした結果になります。(ピーク電位がありませんが。)

これでシミュレーションの流れが分かりました。

発展として、xi(標準正規分布の確率変数)を使うことで、ノイズを含んだ確率微分方程式を扱うこともできるようです。複数の神経細胞のスパイクシミュレーション

次に複数の神経細胞のスパイクをシミュレーションします。

今回は各細胞に異なる入力電位(I)を与えてみます。from brian2 import * start_scope() N = 100 #細胞の数 tau = 10*ms #膜時定数 v0 = -50*mV #静止膜電位 eqs = ''' dv/dt = (v0-v+I)/tau : volt (unless refractory) I : volt ''' G = NeuronGroup(N, eqs, threshold='v>-40*mV', reset='v=-60*mV', refractory=1*ms, method='exact') G.v = -70*mV膜電位変化ではなくスパイクのみを見たいときは

SpikeMonitorを使います。M = SpikeMonitor(G)各細胞に異なる入力を定義します。

I_max = 40*mV G.I = 'i*I_max/(N-1)'iは細胞のインデックスになります。これで異なる入力を定義できました。

runします。

duration = 1000*ms run(duration)ラスタープロットを作成します。

plot(M.t/ms, M.i, '.k') xlabel('Time (ms)') ylabel('Neuron index');細胞のインデックスが上がるごとに入力電位が上がるので、スパイクが多くなりました。

よく見るF-Iカーブも作ってみます。

plot(G.I/mV, M.count/duration) xlabel('Input (mV)') ylabel('Firing rate (sp/s)');これがReLU関数に似ていると言われますね。

神経回路をシミュレーションするには

神経回路のシミュレーションも簡単に出来るようです。(試したら更新します。)

シナプスは

Synapsesモジュールで定義できます。

connectメソッドで細胞の結合が行われます。(どの細胞からどの細胞へつなげるか)シナプスの強度に微分方程式を定義することもできて、STDPモデルも作れるようです。

他にも

Networkでネットワークの定義ができたりするようです。感想

シミュレーションのための機能が充実していて、使いやすいと思いました。

ドキュメントには他にも様々な例が載っています。

https://brian2.readthedocs.io/en/stable/examples/index.html

コンパートメントモデルの例もありました。

これらも試してみたいですね。*追記

今年の1月にBrian2GeNNというものが発表されていました。

https://www.nature.com/articles/s41598-019-54957-7

これでGPUも活用できるようになったみたいです。

- 投稿日:2020-05-26T22:00:26+09:00

im2col徹底理解

対象者

CNNを用いた画像認識で登場する

im2col関数について詳しく知りたい方へ

初期の実装から改良版、バッチ・チャンネル対応版、ストライド・パディング対応版までgifや画像を用いて徹底解説します。目次

im2colとは

im2colは、画像認識において用いられている関数です。動作としては多次元配列を2次元配列へ、可逆的に変換します。

これの最大のメリットは高速な行列演算ができるnumpyの恩恵を最大限に受けられることでしょう。

これなくして今日の画像認識の発展はなかったと言っても過言ではありません(たぶん)。なぜ必要か

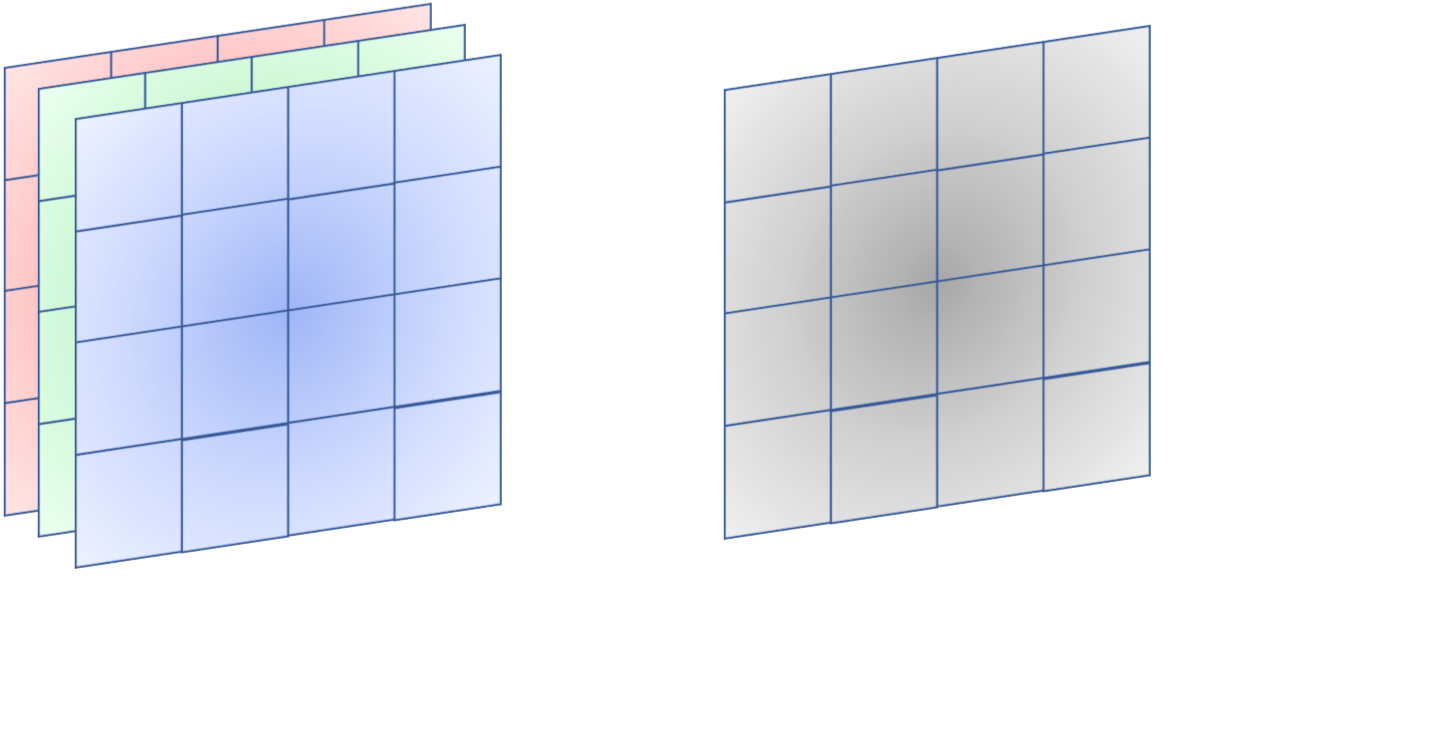

画像はもともと2次元のデータ構造をしていると思いますよね?

見た目は確かに2次元ですが、実際に機械学習する際はRGBに分解した(これをチャンネルといいます)画像を用いることが多いです。

つまり、カラー画像は3次元のデータ構造をしていることになります。

また、白黒画像はチャンネル数が1ですが、一度の伝播で複数の画像を流す(これをバッチといいます)ので、3次元のデータ構造となります。

実用上、わざわざ白黒画像だけ3次元にして実装するのは効率が悪いので、白黒画像はチャンネル数1としてカラー画像と揃え、合計で4次元のデータ構造をしています。

二重ループを用いれば1枚ずつ画像に処理をかけていくことができますが、それではnumpyの利点を消してしまいます(numpyはforループなどで回すと遅いという性質があります)。

そのため4次元のデータを2次元にすることでnumpyの利点を最大限活かすことができるim2colという関数が必要となるのです。CNNとは

CNNとは、Convolutional Neural Network: 畳み込みニューラルネットワークの略で、ある座標点とその周囲の座標点に深い関係があるデータに対して用いられます。簡単な例で言えば画像や動画ですね。

CNN登場以前は画像などのデータ構造をニューラルネットワークを用いて学習する場合、2次元のデータを平滑化して1次元のデータとして扱っており、2次元のデータが持つ重要な相関関係を無視していました。

CNNは画像という2次元のデータ構造を保ったまま特徴量を抜き出していくことで画像認識にブレークスルーを引き起こしました。

網膜から視神経への情報伝達の際に行われている処理から着想を得ている技術であり、より人間の認識に近い処理を行うことが可能となりました。フィルタリング

CNNの処理の内容は主にフィルタリング(畳み込み層)とプーリング(プーリング層)と呼ばれる処理です。

フィルタリングとは、画像データから例えば縦線などの特徴を検出する処理を行うものです。

これは人間の網膜細胞が行っている処理と似ています(人間の網膜細胞では特定のパターンに反応し電気信号を発して情報を視神経に伝える細胞があります)。

プーリングとはフィルタリングで抜き出した特徴量のうち、より特徴的な物を抜き出す処理を行うものです。

これは人間の視神経で行われている処理と似ています(視神経から脳へ情報が伝達される時点で神経細胞の数が減っている→情報が圧縮されている)。

データ量削減の観点からこれは非常に優秀な処理で、特徴量をうまく残しながらメモリ節約および計算量を削減することができます。

プーリングの実装にもim2colと別の記事で紹介する予定のcol2imが活躍しますが、今回は特にフィルタリングに注目します。

上のgifはフィルタリングのイメージを表したものです。

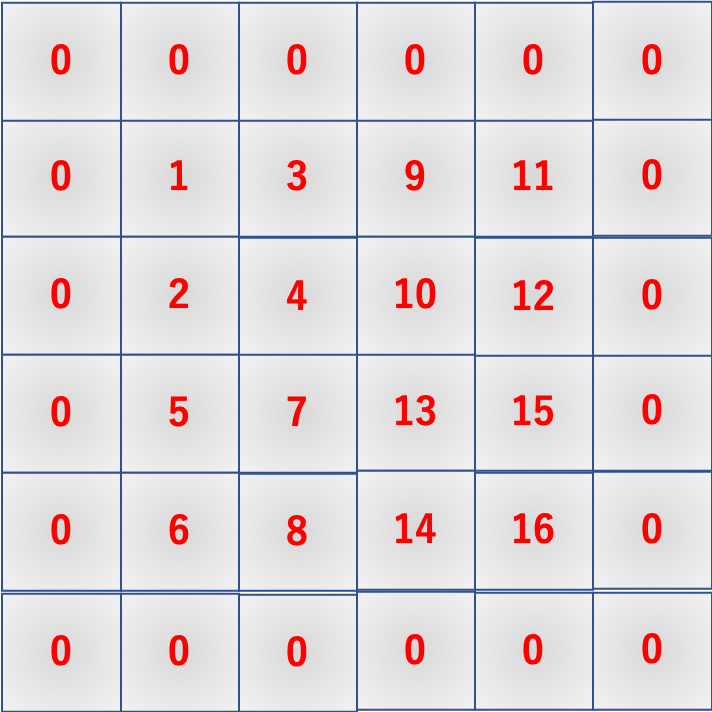

im2colの動作と初期の実装

im2colの実装を理解するために、その動作を数式と画像とgifを用いて徹底的に解剖します。

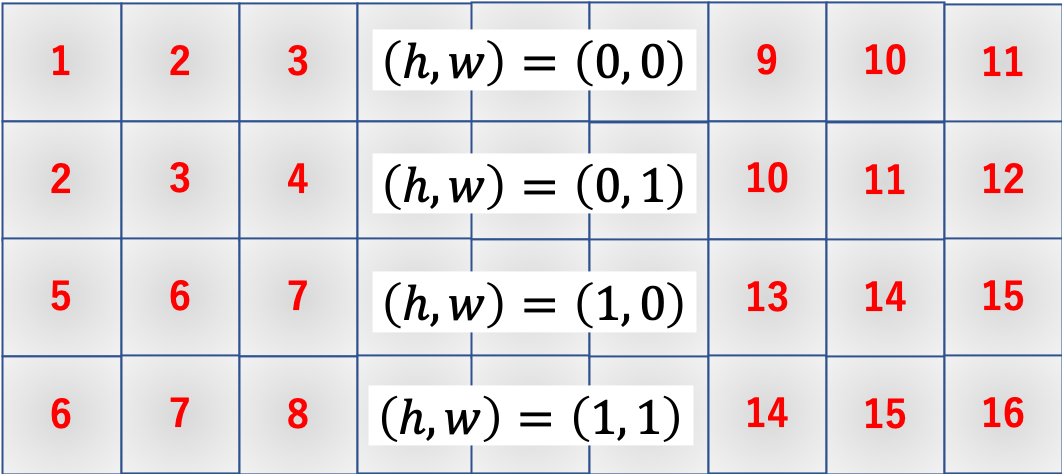

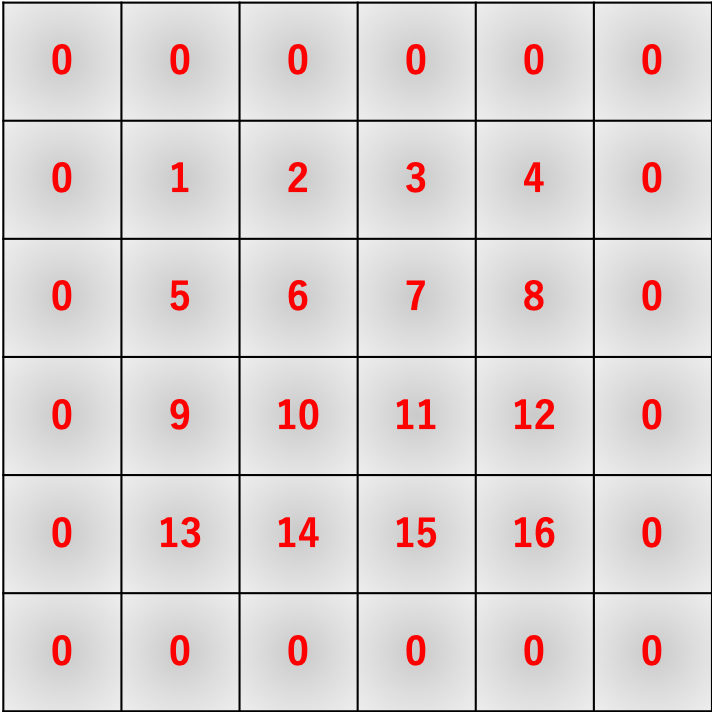

im2colの動作先のgifは数式的には

a = 1W + 2X + 5Y + 6Z \\ b = 2W + 3X + 6Y + 7Z \\ c = 3W + 4X + 7Y + 8Z \\ d = 5W + 6X + 9Y + 10Z \\ e = 6W + 7X + 10Y + 11Z \\ f = 7W + 8X + 11Y + 12Z \\ g = 9W + 10X + 13Y + 14Z \\ h = 10W + 11X + 14Y + 15Z \\ i = 11W + 12X + 15Y + 16Zのようになります。

im2colはこれを行列積演算で実現するためにいい感じに画像データを変形します。

数式でも確認します。\begin{align} \left( \begin{array}{c} a \\ b \\ c \\ d \\ e \\ f \\ g \\ h \\ i \end{array} \right)^{\top} &= \left( \begin{array}{cccc} W & X & Y & Z \end{array} \right) \left( \begin{array}{ccccccccc} 1 & 2 & 3 & 5 & 6 & 7 & 9 & 10 & 11 \\ 2 & 3 & 4 & 6 & 7 & 8 & 10 & 11 & 12 \\ 5 & 6 & 7 & 9 & 10 & 11 & 13 & 14 & 15 \\ 6 & 7 & 8 & 10 & 11 & 12 & 14 & 15 & 16 \end{array} \right) \\ &= \left( \begin{array}{c} 1W + 2X + 5Y + 6Z \\ 2W + 3X + 6Y + 7Z \\ 3W + 4X + 7Y + 8Z \\ 5W + 6X + 9Y + 10Z \\ 6W + 7X + 10Y + 11Z \\ 7W + 8X + 11Y + 12Z \\ 8W + 9X + 12Y + 13Z \\ 10W + 11X + 14Y + 15Z \\ 11W + 12X + 15Y + 16Z \end{array} \right)^{\top} \end{align}

im2colの初期の実装ということで、まずはこれを愚直に実装してみます。

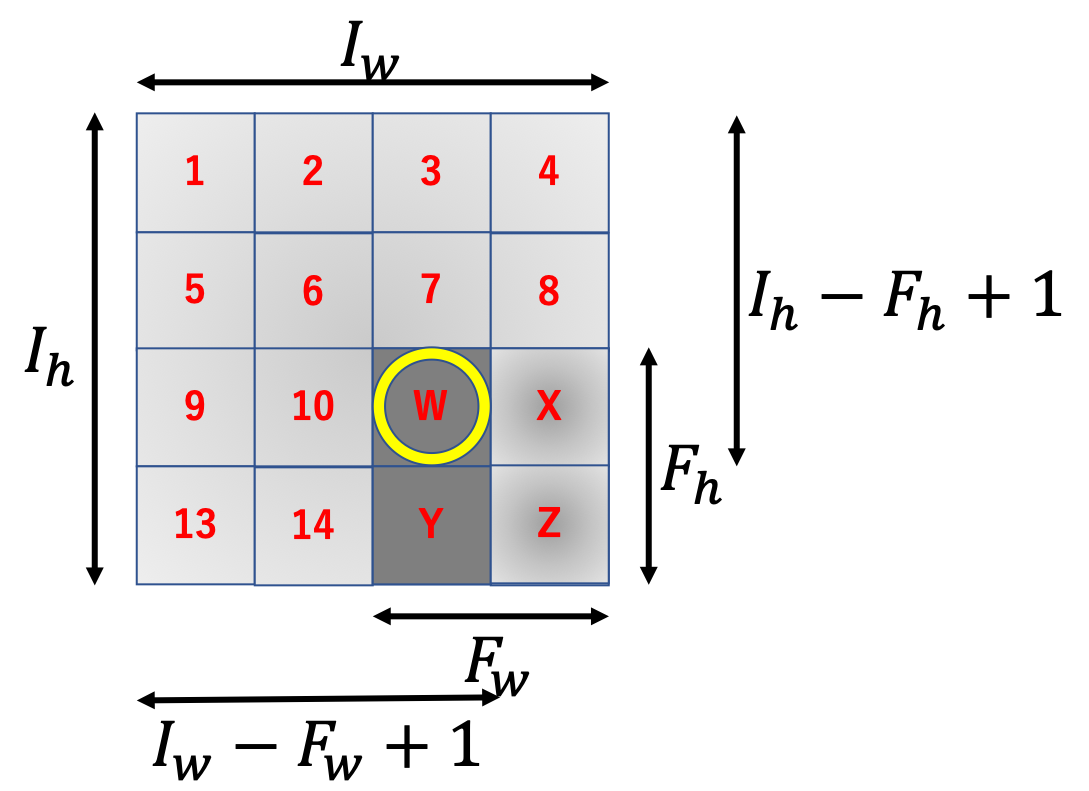

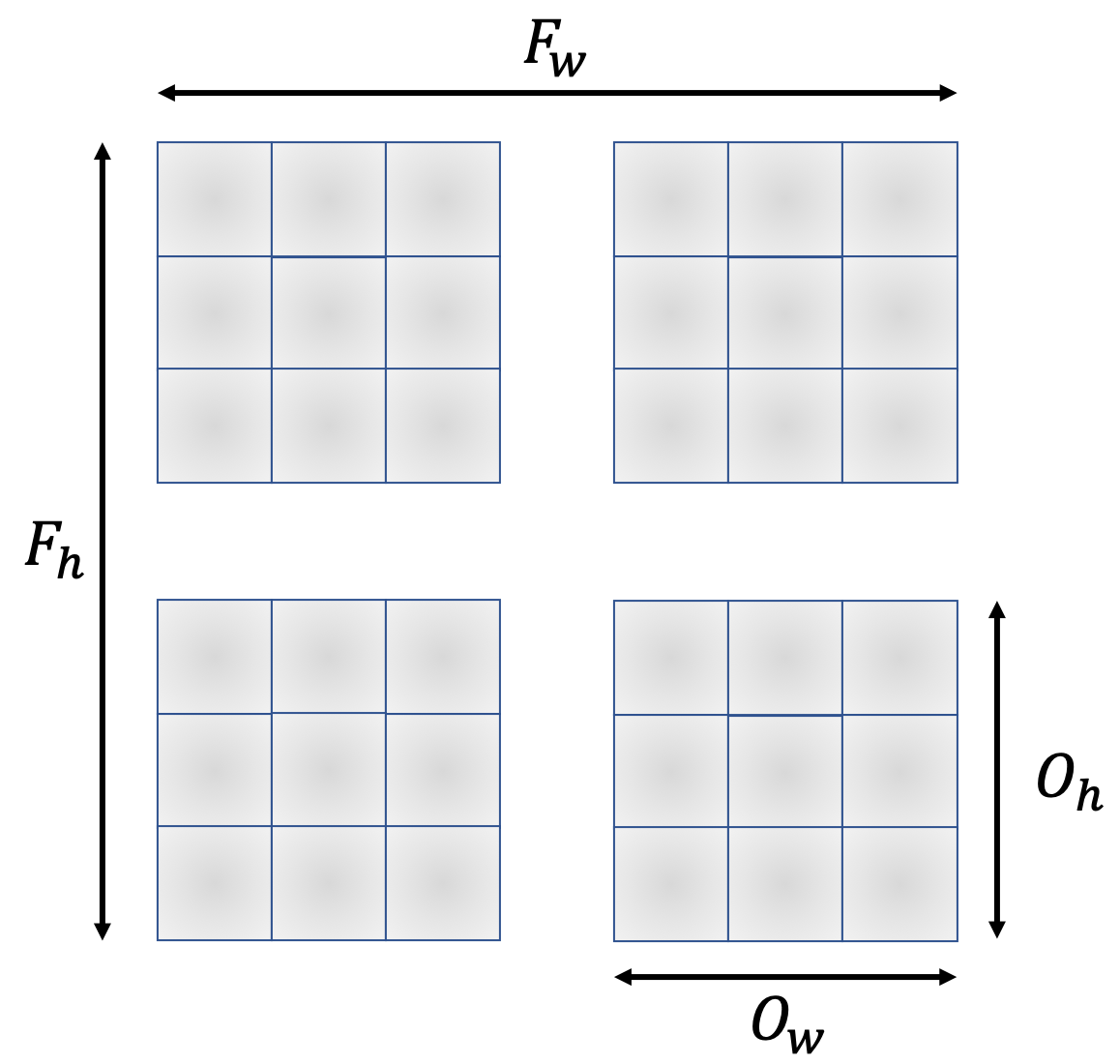

$4 \times 4$の行列に$2 \times 2$のフィルタをかけると$3 \times 3$の行列が出力されます。これを一般化しましょう。

$I_h \times I_w$の行列に$F_h \times F_w$のフィルタをかけることを考えます。

この時、一番最後にフィルタをかけた時の、フィルタの一番左上のインデックスが出力行列のサイズと一致します。フィルタをかける回数と出力行列のサイズが一致するからですね。

画像から、出力行列のサイズは$(I_h - F_h + 1) \times (I_w - F_w + 1) = O_h \times O_w$のように計算することができます。

つまり、$O_h O_w$個の要素が必要となるため、im2colの列数は$O_h O_w$となります。

一方で、行数はフィルタのサイズに比例しますので$F_hF_w$となるため、$I_h \times I_w$の入力行列に$F_h \times F_w$のフィルタをかける時、im2colの出力行列は$F_h F_w \times O_h O_w$となります。

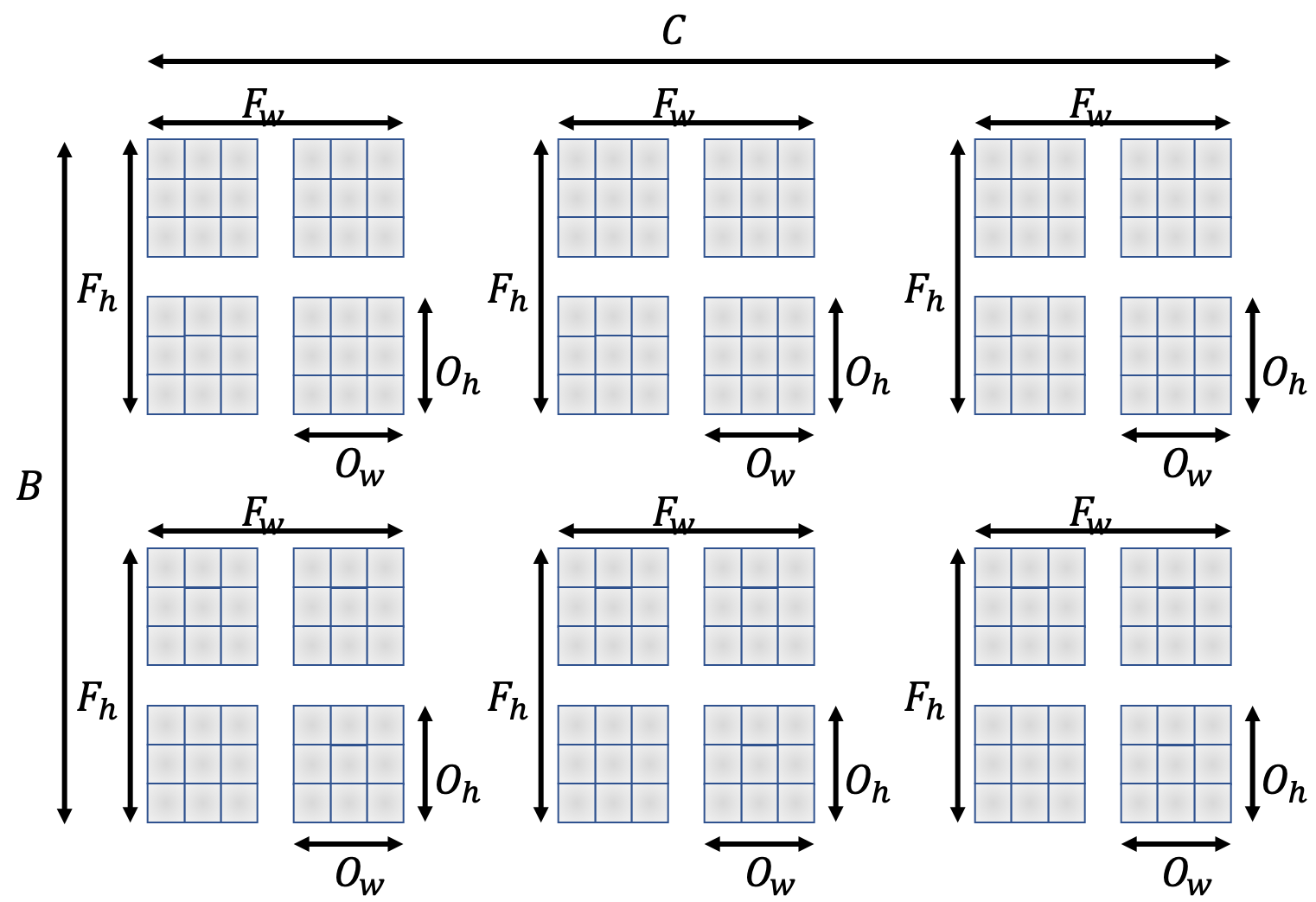

以上をプログラムに落とし込むと次のようになります。

初期のim2col

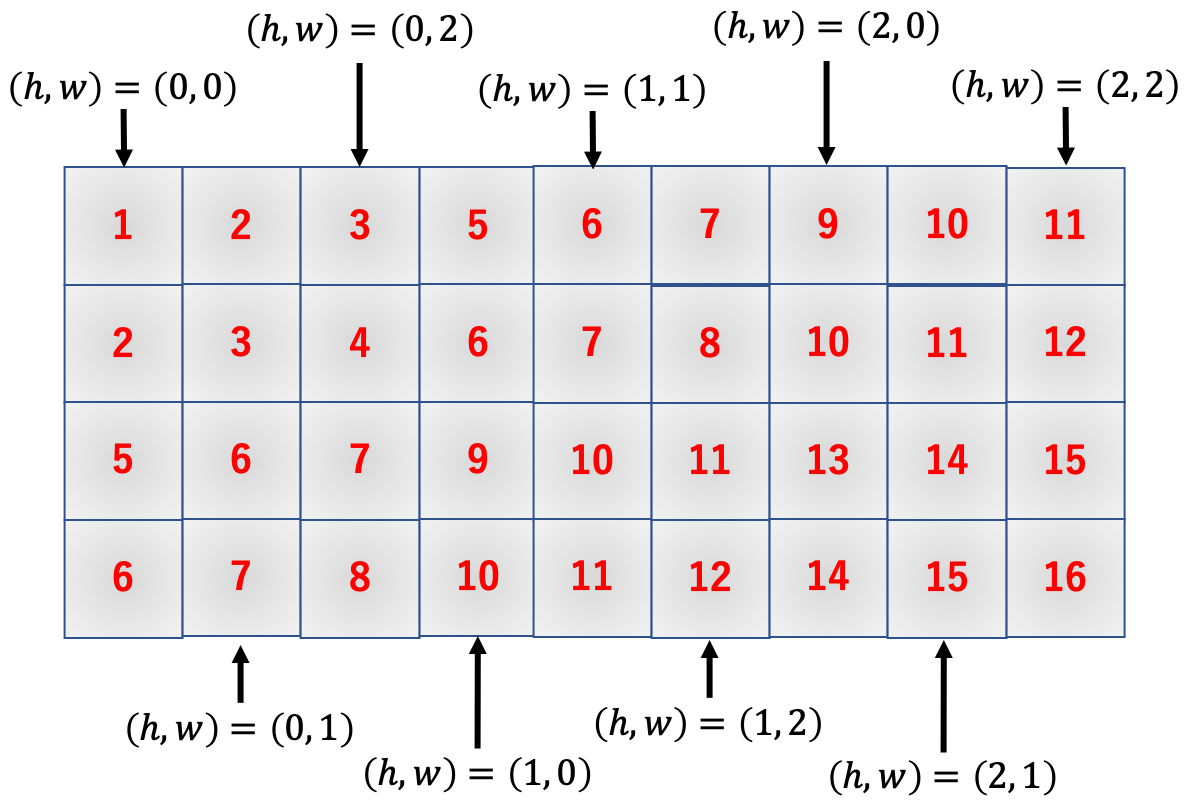

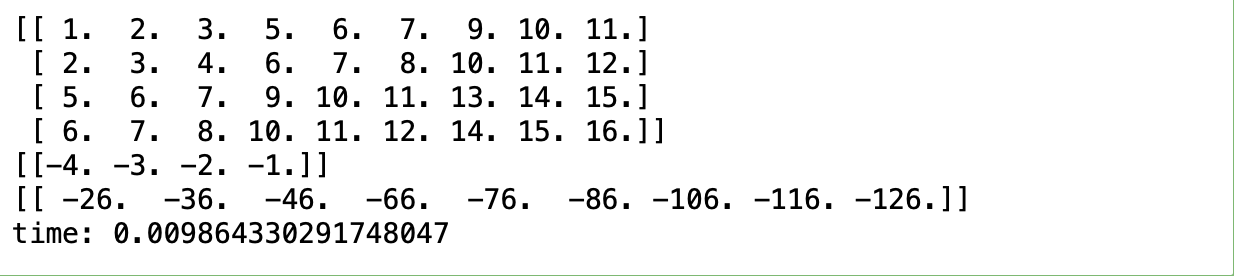

early_im2col.pyimport time import numpy as np def im2col(image, F_h, F_w): I_h, I_w = image.shape O_h = I_h - F_h + 1 O_w = I_w - F_w + 1 col = np.empty((F_h*F_w, O_h*O_w)) for h in range(O_h): for w in range(O_w): col[:, w + h*O_w] = image[h : h+F_h, w : w+F_w].reshape(-1) return col x = np.arange(1, 17).reshape(4, 4) f = np.arange(-4, 0).reshape(2, 2) print(im2col(x, 2, 2)) print(im2col(f, 2, 2).T) print(im2col(f, 2, 2).T @ im2col(x, 2, 2))

行列のサイズに関しての計算は上記の通りです。

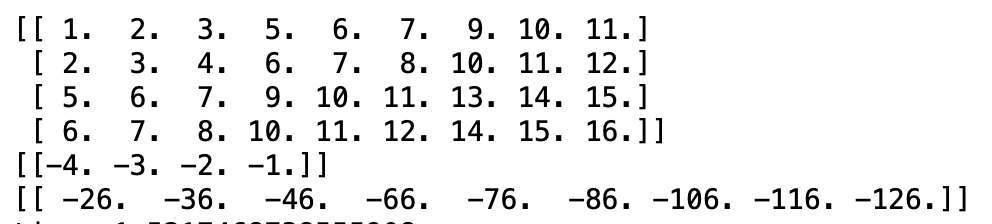

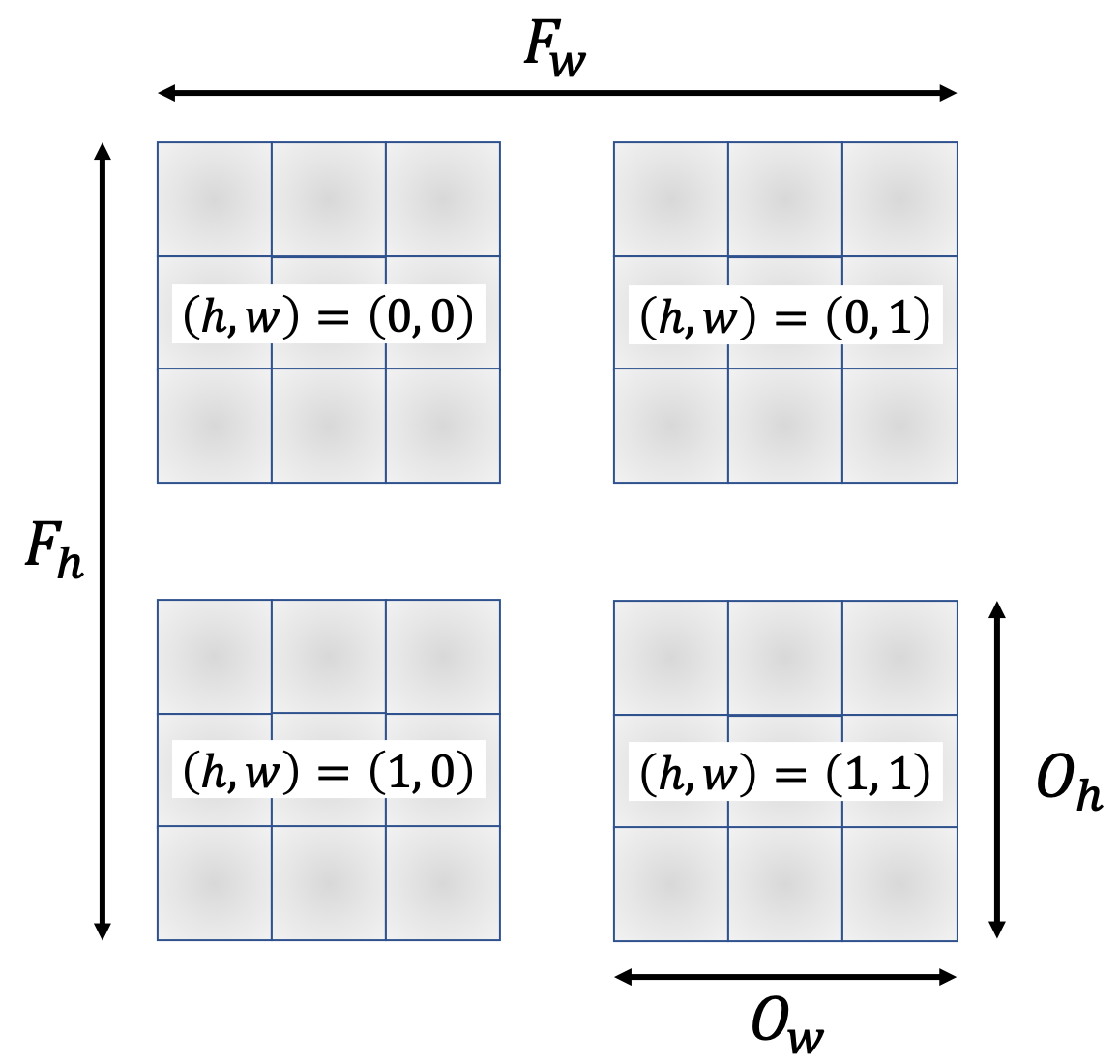

以下では実際に変形しているところの実装を見てみます。early_im2col.pyfor h in range(O_h): for w in range(O_w): col[:, w + h*O_w] = image[h : h+F_h, w : w+F_w].reshape(-1)各

h, wに対応する出力行列への書き込み場所は以下の通りです。

col[:, w + h*O_w]で指定されている書き込み場所ですね。ここに入力行列の該当箇所image[h : h+F_h, w : w+F_w]を.reshape(-1)で平滑化して代入しています。

まだ簡単ですね。初期の

im2colの問題点さて、early_im2col.pyには重大な欠点が存在します。

その欠点とは、先にも述べた通りnumpyはforなどのループ処理でアクセスすると遅くなるという欠点に由来するものです。

一般に、early_im2dol.pyで動作例として紹介している入力配列xはもっとずっと大きいものです(例えばすごく画像サイズの小さいデータセットであるMNISTの手書き数字画像は$28 \times 28$の行列です)。

処理時間を計測してみましょう。early_im2col.pyy = np.zeros((28, 28)) start = time.time() for i in range(1000): im2col(y, 2, 2) end = time.time() print("time: {}".format(end - start))

高々$28 \times 28$の行列に対して1000回処理を行っただけで1.5秒もの時間がかかってしまいます。

MNISTデータベースは実に6万枚もの手書き数字データベースですので、単純計算で全ての画像に1回ずつフィルタリングするだけで900秒かかる計算になります。

実際の機械学習では複数のフィルタを数多の回数かけるため、これでは実用的ではありません。改良版

im2col(初期ver)問題点を復習すると、つまり

forループでnumpy配列にアクセスする回数が多いことが問題であることがわかります。ということはアクセス回数を減らせば良いわけです。

early_im2col.pyでは、numpy配列であるimageに$O_h O_w$回アクセスしており、$28 \times 28$の入力行列に$2 \times 2$のフィルタをかける処理ではアクセス回数は実に$27 \times 27 = 729$回となります。

ところで、一般に出力行列よりもフィルタの方が圧倒的にサイズが小さいため、これを利用すると等価な処理でnumpy配列へのアクセス回数を劇的に減らすことができます。

それが改良版im2col(初期ver)です。

なかなかトリッキーなことをしています。

改良版

im2col(初期ver)

improved_early_im2col.pyimport time import numpy as np def im2col(image, F_h, F_w): I_h, I_w = image.shape O_h = I_h - F_h + 1 O_w = I_w - F_w + 1 col = np.empty((F_h, F_w, O_h, O_w)) for h in range(F_h): for w in range(F_w): col[h, w, :, :] = image[h : h+O_h, w : w+O_w] return col.reshape(F_h*F_w, O_h*O_w) x = np.arange(1, 17).reshape(4, 4) f = np.arange(-4, 0).reshape(2, 2) print(im2col(x, 2, 2)) print(im2col(f, 2, 2).T) print(im2col(f, 2, 2).T @ im2col(x, 2, 2)) y = np.zeros((28, 28)) start = time.time() for i in range(1000): im2col(y, 2, 2) end = time.time() print("time: {}".format(end - start))

結果はご覧の通り、150倍もの高速化に成功しました!

これなら6万枚に1回ずつ処理を行っても6秒で済むため(先ほどよりは)実用的になりました。

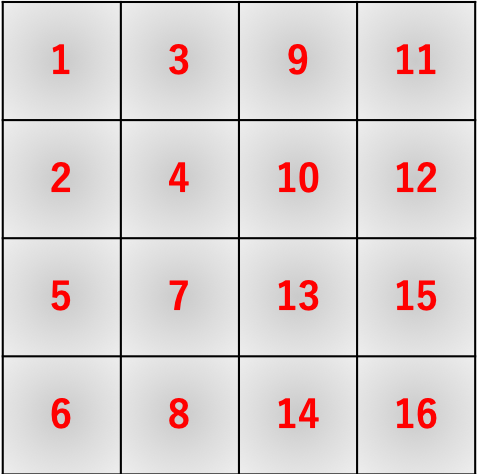

では、具体的に何がどう変わったのかを追っていきます。変更点1

まず最初の変更点としては、出力行列のメモリ確保部分ですね。

improved_early_im2col.pycol = np.empty((F_h, F_w, O_h, O_w))変更点2

続いての変更点は、アクセス回数を減らすためにループ回数を$O_h O_w$から$F_h F_w$にしているところですね。

improved_early_im2col.pyfor h in range(F_h): for w in range(F_w): col[h, w, :, :] = image[h : h+O_h, w : w+O_w]これにより、MNIST画像一枚あたりのnumpy配列アクセス回数が729回からなんと4回にまで減少します!

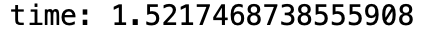

また、各ループでの出力配列へのアクセス場所と入力配列へのアクセス場所は以下のようになっています。

このようにアクセスすると以下のような出力配列ができます。

変更点3

最後に出力時に求める形状に整形します。

improved_early_im2col.pyreturn col.reshape(F_h*F_w, O_h*O_w)numpyの動作的には$(F_h, F_w, O_h, O_w)$を平滑化した$(F_h F_w O_h O_w, )$の1次元データを$(F_h F_w, O_h O_w)$の2次元データに変形している感じです。

もっと噛み砕いて言うと、図の一つ一つの2次元データを1次元に平滑化して下に積んでいく感じです。

上手いこと考えますよね〜多次元配列への拡張

さて、

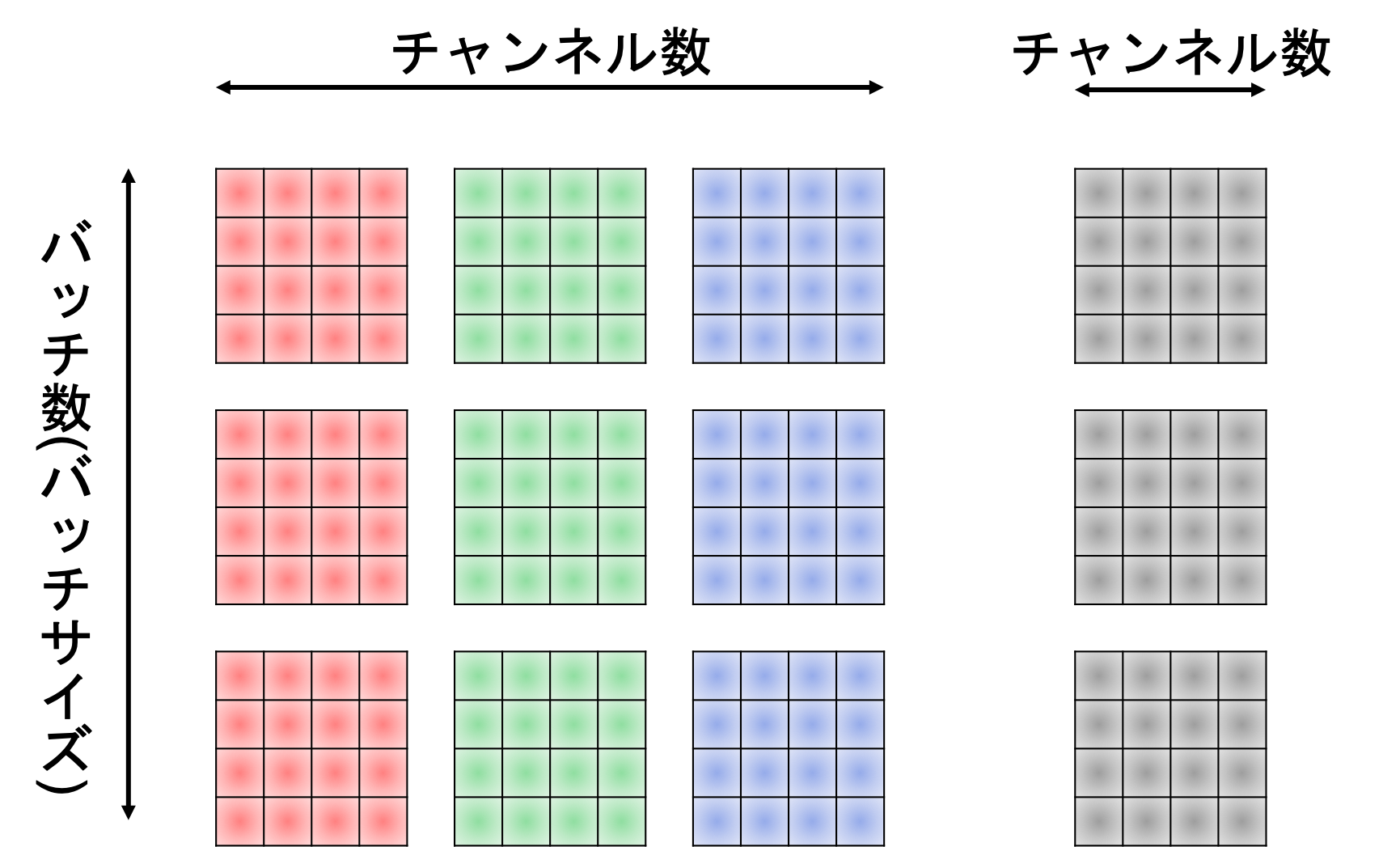

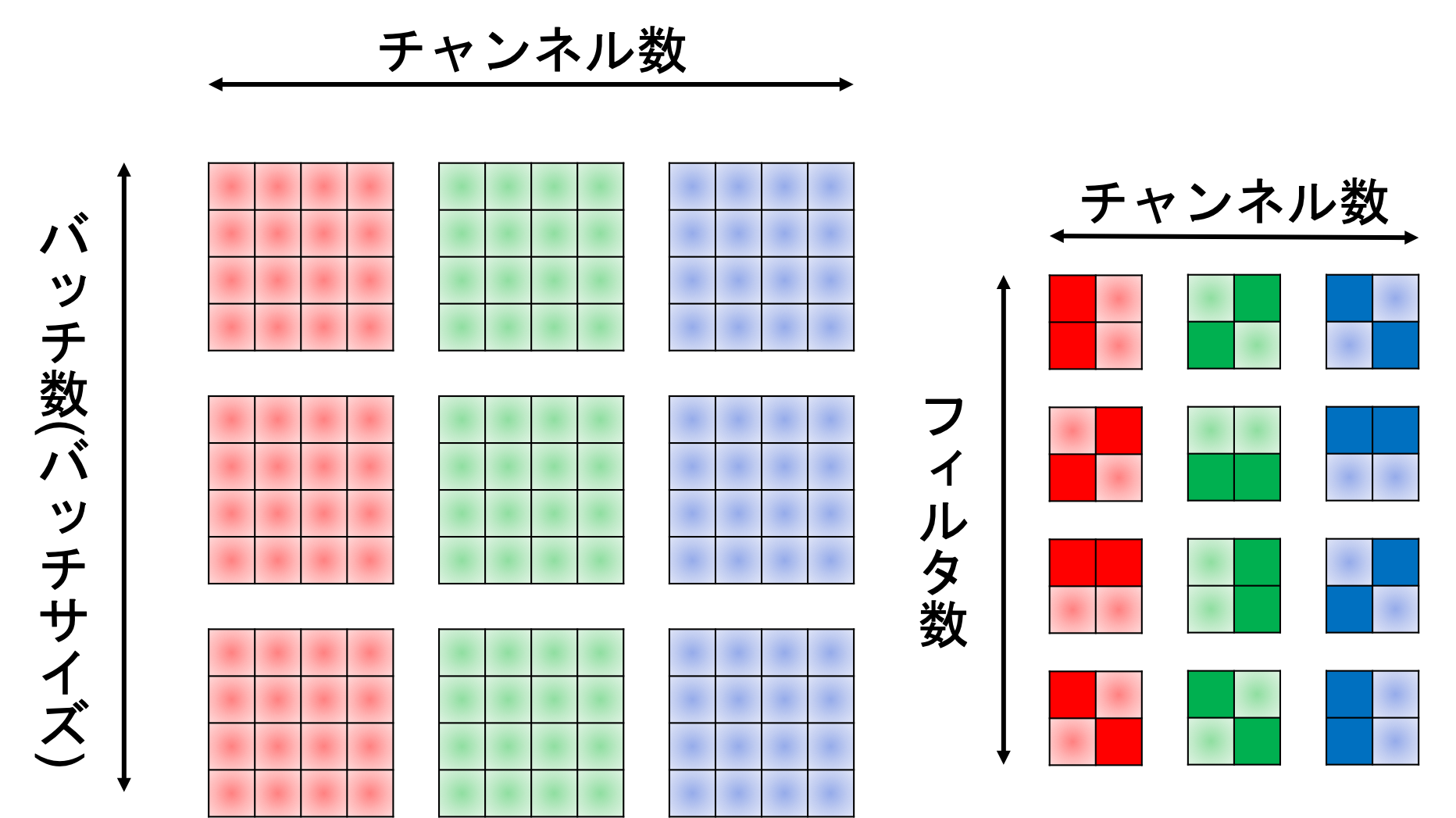

im2colとはで述べたように、本来この関数の対象の行列は4次元のデータ構造をしています。

フィルタも入力行列のチャンネル数分はまず確保し、それに加えてそのセットを$M$個用意した4次元のデータ構造をしています。

これを加味してimproved_early_im2col.pyを修正していきます。数式で追いかける

まずは数学的にどのような形状に変形する必要があるかを考えましょう。

カラー画像の構造は、チャンネル数を$C$、バッチサイズを$B$とすると$(B, C, I_h, I_w)$という構造をしています。

一方でフィルタは$(M, C, F_h, F_w)$という構造をしています。

improved_early_im2col.pyでは$(I_h, I_w)$の行列に$(F_h, F_w)$のフィルタをかける場合出力される行列が$(F_h F_w, O_h O_w)$および$(1, F_h F_w)$でしたね。

$B=1$と$M=1$を仮定すると、フィルタリングを行列積で計算させるためには、im2colで変形された入力データとフィルタの形状のそれぞれの行と列が一致していなければならないため、$(C F_h F_w, O_h O_w)$および$(1, C F_h F_w)$となります。

また、一般的に$B \ne M$であるから、これらは$C F_h F_w$とは関係ない方に組み合わせる必要があります。

これらの事実を組み合わせると、im2colで出力されるべき配列の形状は$(C F_h F_w, B O_h O_w)$および$(M, C F_h F_w)$となります。

ついでに、フィルタリングの計算結果としては$(M, C F_h F_w) \times (C F_h F_w, B O_h O_w) = (M, B O_h O_w)$となり、これをreshapeして次元を入れ替えた$(B, M, O_h, O_w):=(B, C', I_h', I_w')$が次の層への入力として伝播していきます。実装してみる

実装内容はほとんどimproved_early_im2col.pyと変わりません。上位にバッチとチャンネルの次元を追加しただけです。

バッチ・チャンネル対応

im2col

BC_support_im2col.pyimport time import numpy as np def im2col(images, F_h, F_w): B, C, I_h, I_w = images.shape O_h = I_h - F_h + 1 O_w = I_w - F_w + 1 cols = np.empty((B, C, F_h, F_w, O_h, O_w)) for h in range(F_h): for w in range(F_w): cols[:, :, h, w, :, :] = images[:, :, h : h+O_h, w : w+O_w] return cols.transpose(1, 2, 3, 0, 4, 5).reshape(C*F_h*F_w, B*O_h*O_w) x = np.arange(1, 3*3*4*4+1).reshape(3, 3, 4, 4) f = np.arange(-3*3*2*2, 0).reshape(3, 3, 2, 2) print(im2col(x, 2, 2)) print(im2col(f, 2, 2).T) print(np.dot(im2col(f, 2, 2).T, im2col(x, 2, 2))) y = np.zeros((100, 3, 28, 28)) start = time.time() for i in range(10): im2col(y, 2, 2) end = time.time() print("time: {}".format(end - start))

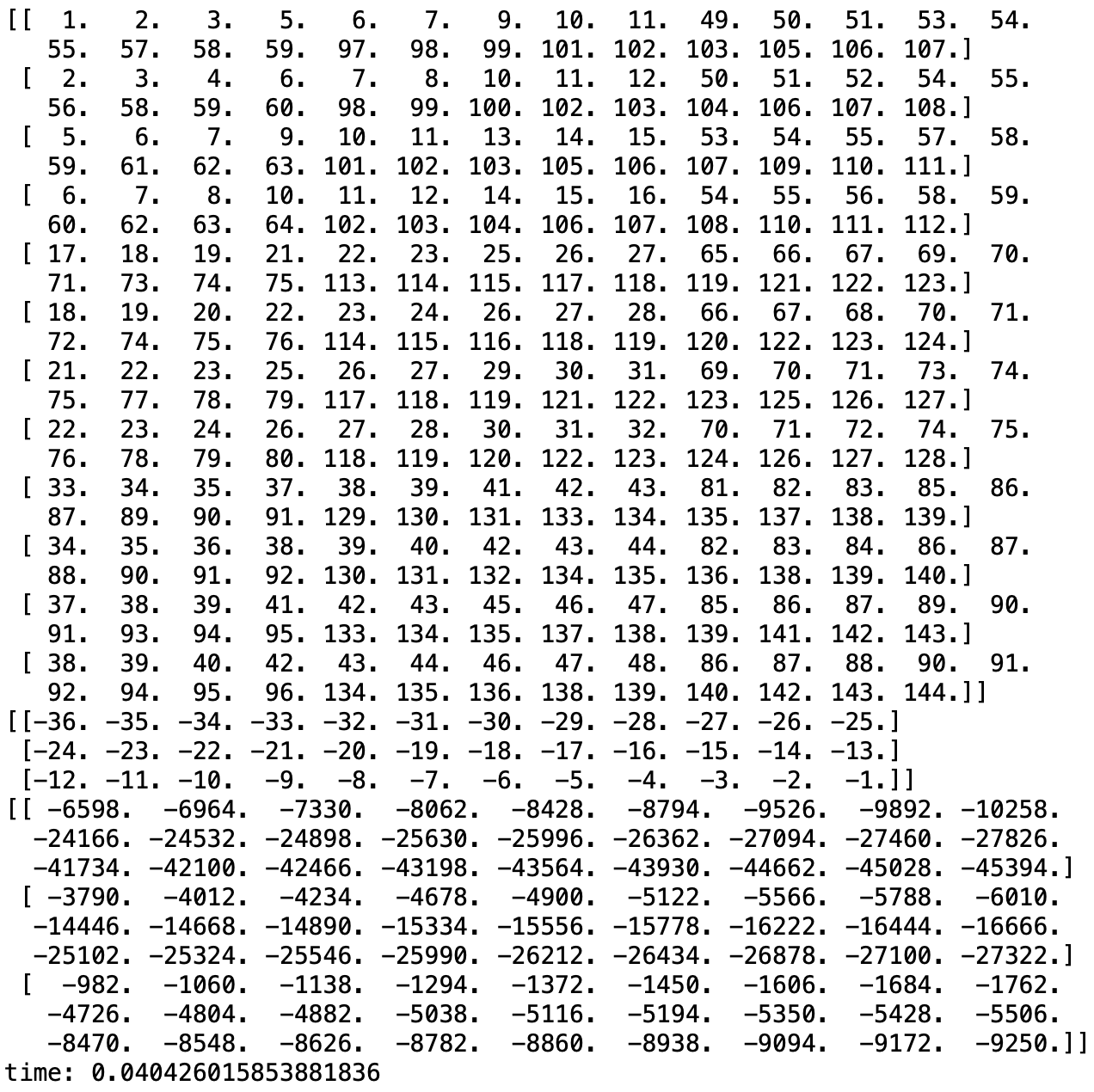

最大の変化は返り値の部分ですね。BC_support_im2col.pyreturn cols.transpose(1, 2, 3, 0, 4, 5).reshape(C*F_h*F_w, B*O_h*O_w)ここでは、numpyの

transpose関数を用いて次元の順番を入れ替えています。

それぞれ以下のように対応しており、順番を入れ替えてからreshapeすることで正しい出力を返します。\begin{array}{ccccccc} (&0, &1, &2, &3, &4, &5) \\ (&B, &C, &F_h, &F_w, &O_h, &O_w) \end{array} \xrightarrow[\textrm{transpose}]{入れ替え} \begin{array}{ccccccc} (&1, &2, &3, &0, &4, &5) \\ (&C, &F_h, &F_w, &B, &O_h, &O_w) \end{array} \xrightarrow[\textrm{reshape}]{変形} (C F_h F_w, B O_h O_w)これでバッチ・チャンネルにも対応した

im2colが完成です!ストライドとパディング

さて、これで終わりかと思いきやそうでもなかったりします。最後に紹介するのはストライドとパディングと呼ばれる処理です。

いずれもより効率的で効果的なCNNの実装には不可欠な要素です。ストライド

これまでの実装では、当たり前のようにフィルタは1マスずつズレていましたよね?

このズレる量のことをストライドといいますが、これは何も1マスずつでなければならないという決まりはありません。

実際の画像はわずか1ピクセルズレるだけで情報が大きく変わるような場面の方が少ないため、大抵の場合ストライドは1ではないでしょう。パディング

ストライドと違ってパディングはこれまでの実装で一切触れられていません。

その主な役目はフィルタリングによって出力画像のサイズが変わらないようにすることと、画像の端の方の情報を余さず得ることです。

具体的には入力画像の周囲を$0$で埋めることでフィルタが動く範囲を広げています。

ストライドとパディングの実装

ではそれぞれの実装について見ていきます。

ストライドの実装

ストライドの実装はそんなに難しくないですね。これまでのストライド移動幅を1から変更できるようにするだけです。

今までBC_support_im2col.pycols[:, :, h, w, :, :] = images[:, :, h : h+O_h, w : w+O_w]のようにしていましたが、これを

im2col.pycols[:, :, h, w, :, :] = images[:, :, h : h + stride*O_h : stride, w : w + stride*O_w : stride]a = 1W + 2X + 5Y + 6Z \\ b = 3W + 4X + 7Y + 8Z \\ c = 9W + 10X + 13Y + 14Z \\ d = 11W + 12X + 15Y + 16Z \\ \Leftrightarrow \left( \begin{array}{c} a \\ b \\ c \\ d \end{array} \right)^{\top} = \left( \begin{array}{cccc} W & X & Y & Z \end{array} \right) \left( \begin{array}{cccc} 1 & 3 & 9 & 11 \\ 2 & 4 & 10 & 12 \\ 5 & 7 & 13 & 15 \\ 6 & 8 & 14 & 16 \end{array} \right)こんな感じで、改良版だとこんな感じですね。

やっぱりトリッキーですね...これ考えた人凄すぎです。パディングの実装

一方パディングの処理の実装は至ってシンプルです。

numpyにあるpad関数を用いてim2col.pyimages = np.pad(images, [(0, 0), (0, 0), (pad, pad), (pad, pad)], "constant")とすればOK。

pad関数の動作は結構ややこしいので(後日紹介します)、とりあえず上記の解説をしておきます。

padの第一引数は対象の配列です。これは大丈夫でしょう。

問題は第二引数です。im2col.py[(0, 0), (0, 0), (pad, pad), (pad, pad)]

pad関数にこのように入力すると、

- 1次元目は

(0, 0)、つまりパディングなし- 2次元目は

(0, 0)、つまりパディングなし- 3次元目は

(pad, pad)、つまり上下の増量幅padで0埋め("constant")- 4次元目は

(pad, pad)、つまり左右の増量幅padで0埋め("constant")第三引数はいくつか指定できるものがありますが、今回は0埋めしたいので

"constant"を指定しています。

詳しくは公式ドキュメントを見てください。出力次元の計算

さて、上記の変更を施して実行してもまだエラーが出て動きませんね。はい。

理由はお察しの通り、ストライドとパディングの実装とともに出力次元が変わるからです。どのように変わるのか考えて見ましょう。ストライドの影響

ストライド幅を増やすとフィルタをかける回数が反比例的に減少します。

フィルタを1マスごとにかけるか2マスごとにかけるかで回数が半減することは察しがつくでしょう。

数式で表すとO_h = \cfrac{I_h - F_h}{\textrm{stride}} + 1\\ O_w = \cfrac{I_w - F_w}{\textrm{stride}} + 1という感じになります。

$I_h = 4, F_h = 2, \textrm{stride} = 1$の場合は

$O_h = \cfrac{4 - 2}{1} + 1 = 3$

となり、$I_h = 4, F_h = 2, \textrm{stride} = 2$の場合は

$O_h = \cfrac{4 - 2}{2} + 1 = 2$

となり、これまでの画像と一致することが確認できますね。パディングの影響

パディングの影響はすごくシンプルです。入力画像1枚ごとのサイズが上下$+ \textrm{pad}_{ud}$、左右$+ \textrm{pad}_{lr}$されるため、

I_h \leftarrow I_h + 2\textrm{pad}_{ud} \\ I_w \leftarrow I_w + 2\textrm{pad}_{lr}と置き換えればよく、つまり

O_h = \cfrac{I_h - F_h + 2\textrm{pad}_{ud}}{\textrm{stride}} + 1 \\ O_w = \cfrac{I_w - F_w + 2\textrm{pad}_{lr}}{\textrm{stride}} + 1となります。

また逆に、出力画像のサイズを入力画像のサイズに揃えたい場合は$O_h = I_h$および$O_w = I_w$なので\textrm{pad}_{ud} = \cfrac{1}{2}\left\{(I_h - 1) \textrm{stride} - I_h + F_h\right\} \\ \textrm{pad}_{lr} = \cfrac{1}{2}\left\{(I_w - 1) \textrm{stride} - I_w + F_w\right\}のように計算できます。

ついでにストライドも自由度を上げておきましょう。O_h = \cfrac{I_h - F_h + 2\textrm{pad}_{ud}}{\textrm{stride}_{ud}} + 1 \\ O_w = \cfrac{I_w - F_w + 2\textrm{pad}_{lr}}{\textrm{stride}_{lr}} + 1 \\ \textrm{pad}_{ud} = \cfrac{1}{2}\left\{(I_h - 1) \textrm{stride}_{ud} - I_h + F_h\right\} \\ \textrm{pad}_{lr} = \cfrac{1}{2}\left\{(I_w - 1) \textrm{stride}_{lr} - I_w + F_w\right\}完成版

im2colストライドとパディングを加味して自由度を上げた

im2colは次のようになります。

ついでにいくつかカスタマイズも施しておきます。

im2col.py

im2col.pyimport numpy as np def im2col(images, filters, stride=1, pad=0, get_out_size=True): if images.ndim == 2: images = images.reshape(1, 1, *images.shape) elif images.ndim == 3: B, I_h, I_w = images.shape images = images.reshape(B, 1, I_h, I_w) if filters.ndim == 2: filters = filters.reshape(1, 1, *filters.shape) elif images.ndim == 3: M, F_h, F_w = filters.shape filters = filters.reshape(M, 1, F_h, F_w) B, C, I_h, I_w = images.shape _, _, F_h, F_w = filters.shape if isinstance(stride, tuple): stride_ud, stride_lr = stride else: stride_ud = stride stride_lr = stride if isinstance(pad, tuple): pad_ud, pad_lr = pad elif isinstance(pad, int): pad_ud = pad pad_lr = pad elif pad == "same": pad_ud = 0.5*((I_h - 1)*stride_ud - I_h + F_h) pad_lr = 0.5*((I_w - 1)*stride_lr - I_w + F_w) pad_zero = (0, 0) O_h = int(np.ceil((I_h - F_h + 2*pad_ud)/stride_ud) + 1) O_w = int(np.ceil((I_w - F_w + 2*pad_lr)/stride_lr) + 1) pad_ud = int(np.ceil(pad_ud)) pad_lr = int(np.ceil(pad_lr)) pad_ud = (pad_ud, pad_ud) pad_lr = (pad_lr, pad_lr) images = np.pad(images, [pad_zero, pad_zero, pad_ud, pad_lr], \ "constant") cols = np.empty((B, C, F_h, F_w, O_h, O_w)) for h in range(F_h): h_lim = h + stride_ud*O_h for w in range(F_w): w_lim = w + stride_lr*O_w cols[:, :, h, w, :, :] \ = images[:, :, h:h_lim:stride_ud, w:w_lim:stride_lr] if get_out_size: return cols.transpose(1, 2, 3, 0, 4, 5).reshape(C*F_h*F_w, B*O_h*O_w), (O_h, O_w) else: return cols.transpose(1, 2, 3, 0, 4, 5).reshape(C*F_h*F_w, B*O_h*O_w)簡単に解説していきます。

整形など

im2col.pydef im2col(images, filters, stride=1, pad=0, get_out_size=True): if images.ndim == 2: images = images.reshape(1, 1, *images.shape) elif images.ndim == 3: B, I_h, I_w = images.shape images = images.reshape(B, 1, I_h, I_w) if filters.ndim == 2: filters = filters.reshape(1, 1, *filters.shape) elif images.ndim == 3: M, F_h, F_w = filters.shape filters = filters.reshape(M, 1, F_h, F_w) B, C, I_h, I_w = images.shape _, _, F_h, F_w = filters.shape if isinstance(stride, tuple): stride_ud, stride_lr = stride else: stride_ud = stride stride_lr = stride if isinstance(pad, tuple): pad_ud, pad_lr = pad elif isinstance(pad, int): pad_ud = pad pad_lr = pad elif pad == "same": pad_ud = 0.5*((I_h - 1)*stride_ud - I_h + F_h) pad_lr = 0.5*((I_w - 1)*stride_lr - I_w + F_w) pad_zero = (0, 0)

この部分では

- 引数の数を削減するためにフィルタそのものを引数に取るように変更

- 入力画像が4次元でなければ4次元に変換

- フィルタが4次元でなければ4次元に変換

- バッチサイズ、チャンネル数、入力画像一枚のサイズを取得

- フィルタの数とフィルタのチャンネル数は不要なため捨てて(

_, _, ...の部分)、フィルタ一枚のサイズを取得strideがtupleなら上下と左右のストライド幅を個別に指定しているとみなし、そうでなければ同じ値を用いるpadがtupleなら上下と左右のパディング幅を個別に指定しているとみなし、そうでなければ同じ値を用いるpad == "same"と指定された場合は、入力画像のサイズを維持するパディング幅をfloatで計算(後の出力サイズ計算のため)という感じの処理をしています。

準備

im2col.pyO_h = int(np.ceil((I_h - F_h + 2*pad_ud)/stride_ud) + 1) O_w = int(np.ceil((I_w - F_w + 2*pad_lr)/stride_lr) + 1) pad_ud = int(np.ceil(pad_ud)) pad_lr = int(np.ceil(pad_lr)) pad_ud = (pad_ud, pad_ud) pad_lr = (pad_lr, pad_lr) images = np.pad(images, [pad_zero, pad_zero, pad_ud, pad_lr], \ "constant") cols = np.empty((B, C, F_h, F_w, O_h, O_w))ここでは

- 出力画像のサイズを計算

- 可読性の向上のためにパディングをタプルに変更する

- 入力画像にパディングを施す

- 出力用配列のメモリ確保

を行っています。

処理本体と返り値

im2col.pyfor h in range(F_h): h_lim = h + stride_ud*O_h for w in range(F_w): w_lim = w + stride_lr*O_w cols[:, :, h, w, :, :] \ = images[:, :, h:h_lim:stride_ud, w:w_lim:stride_lr] if get_out_size: return cols.transpose(1, 2, 3, 0, 4, 5).reshape(C*F_h*F_w, B*O_h*O_w), (O_h, O_w) else: return cols.transpose(1, 2, 3, 0, 4, 5).reshape(C*F_h*F_w, B*O_h*O_w)最後に、処理本体と返り値についてです。

- 可読性の向上のため、

h_limとw_limという変数を新たに用意し、フィルタリング処理の右端と下端を定義- ストライド幅ごとに入力画像から値を取得し出力用配列

colsに格納- 次元を入れ替えて変形して返す

MNISTで実験

KerasのデータセットからMNISTのデータをダウンロードして実験してみます。

mnist_test.py

mnist_test.py#%pip install tensorflow #%pip install keras #from PIL import Image from keras.datasets import mnist import matplotlib.pyplot as plt # 取得する枚数を指定 B = 3 # データセット取得 (x_train, _), (_, _) = mnist.load_data() x_train = x_train[:B] # 表示してみる fig, ax = plt.subplots(1, B) for i, x in enumerate(x_train): ax[i].imshow(x, cmap="gray") fig.tight_layout() plt.savefig("mnist_data.png") plt.show() # 縦線を検出してみる M = 1 C = 1 F_h = 7 F_w = 7 _, I_h, I_w = x_train.shape f = np.zeros((F_h, F_w)) f[:, int(F_w / 2)] = 1 no_pad, (O_h, O_w) = im2col(x_train, f, stride=2, pad="same") filters = im2col(f, f, get_out_size=False) y = np.dot(filters.T, no_pad).reshape(M, B, O_h, O_w).transpose(1, 0, 2, 3).reshape(B, O_h, O_w) fig2, ax2 = plt.subplots(1, B) for i, x in enumerate(y): ax2[i].imshow(x[F_h : I_h-F_h, F_w : I_w-F_w], cmap="gray") fig2.tight_layout() plt.savefig("filtering.png") plt.show()

最初の2行はtensorflowとkerasをインストールしておく必要があるため入れています。

必要ならコメントの#だけを削除して実行してください。

一度実行すればあとはまたコメントアウトして大丈夫です。

出力結果を見れば分かる通り、それぞれのフィルタをかけた結果、対象の線だけが色濃く残っていますね。

これが特徴量検出です。おわりに

以上で

im2colについての説明は終了となります。

もしバグやもっとスマートな書き方があればコメントなどでご教授いただけると幸いです。参考

- 投稿日:2020-05-26T21:59:33+09:00

2変数、4分岐の if 文について

変数 min_value, max_value が存在するとき、それぞれの条件で処理を変えたい

例えば…

min_value max_value 処理 null null なにもしない null not null 上限より小さいことを検証 not null null 下限より大きいことを検証 not null not null 範囲内にあることを検証 普通はこんな感じ

Main.javaclass Main { public static void main(String[] args) { } private static String hoge(int value, Integer min_value, Integer max_value) { if (min_value == null && max_value == null) { // なにもしない return ""; } if (min_value == null) { // 上限チェック return ""; } if (max_value == null) { // 下限チェック return ""; } // 範囲チェック return ""; } }

- パッと見、分かりづらい

- 比較が一つの場合と、四つの場合が存在し、データによっては速度に違いが出る

- 見た目が悪い

これをなんとか解消したい…

main.swiftfunc hoge(_ value: Int, _ min_value: Int?, _ max_value: Int?) -> String { // Optional が外れない switch(min_value != nil, max_value != nil) { case (true, true): return "" // 範囲チェック case (true, false): return "" // 上限チェック case (false, true): return "" // 下限チェック case (false, false): return "" // 何もしない } }Pytyon3 の場合

main.pydef hoge(value, min_value, max_value): command = { (True, True): lambda: "", # 範囲チェック (True, False): lambda: "", # 下限チェック (False, True): lambda: "", # 上限チェック (False, False): lambda: "", # なにもしない } return command[(min_value is not None, max_value is not None)]()

もっと良い方法がありましたら、教えていただきたいです。

- 投稿日:2020-05-26T21:56:49+09:00

コード規約、メソッド対応表

#python--sqlコード規約

python

#python df_used_method1_used_method2\ = df.copy()\ .used_method1()\ .used_method2()\SQL

--sql select datamart1.column1 , datamart1.column2 , datamart2.column3 from datamart1 left join datamart2 on = column2 where datamart1.column1 > 10 ; select column1 , column2 , sum(column3) , avg(column4) from datamart1 group by column1 , column2 ;SQLルール

- すべて、小文字

- インデントは上記のとおり

メソッド対応表_データ分析関連

テーブルデータのデータ理解/データ準備

キーでユニークになるかの検証

#python--sqlレコードに重複が無いかの検証

#python--sqlカラムの抽出

#python #シリーズ形式で抽出 df.loc[:,'column'] df['column'] df.column #データフレーム形式で抽出 df.loc[:,['column1','column2']] df[['column1','column2']]--sql select column1 from datamart ; select * from datamart ;一部のレコードを抽出

#python df.head(10)--sql select top(10) column1 from datamart ; select column1 from datamart limit 10 ;重複なくカラムを抽出

#python df.drop_duplicates()--sql select unique * from datamart ;カラムの追加

#python df_assign\ = df.copy()\ .assign(column = 10) df['column'] = 10--sql select 10 as column1 from dataframe ;条件に一致するレコードを抽出

#python df_query_loc\ = df.copy()\ .query('column1 == 10')\ .loc[:,['column1','column2']] df[df.column1 == 10, ['column1','column2']]--sql select column1 from datamart1 where column1 == 10 ; select column1 , count(column1) from datamart1 group by column1 having count(column1) == 10 ;カラム名の変更

#python df.rename(columns = {'column1':'new_column1','column2':'new_column2'}) pd.DataFrame(df.values, columns = ['new_column1','new_column2']) df.columns = ['new_column1','new_column2'] df.columns = 'new_' + df.columns--sql select column1 as new_column1 from datamart1 ;dfを結合

#python pd.merge( df1, df2, on = ['column1','column2'], how = 'left') pd.merge( df1, df2, left_on = ['column1','column2'], right_on = ['column3','column4'], how = 'left') df1.merge( df2, on = 'column1', how = 'left')--sql select datamart1.column1 , datamart1.column2 , datamart2.column3 from datamart1 left join datamart2 on = column2複数のデータを一つのデータにする、concat

#python_pandas #縦 pd.concat([df1,df2],axis=0) df1.append(df2) #横 pd.concat([df1,df2],axis=1)#python_numpy #縦 np.concatenate([nparray1,nparray2], axis=0) #横 np.concatenate([nparray1,nparray2], axis=1)--sql select column1 from datamart1 union -- union all / intersect / except select column2 from datamart2行数のカウント

#python len(df)--sql select count(*) from datamart1 ;データの性質をチェック

#python #形状のチェック np.array().shape並び変え

#python df.sort_values()--sql select * from datamart1 order by column1ウィンドウ関数の処理

#python--sqlデータを生成する

#python #すべて同じ値のnparrayを生成 #例、3次元 np.tile(数字, (n, n, n))リスト内包表記

[i for i in range(100)] #if文を使う場合 [i for i in range(100) if i > 50]集約

#python df\ .groupby(['column1','column2'])\ .agg({'column3':'sum', 'column4':'mean'})\ .reset_index()-- sql select column1 , column2 , sum(column3) , avg(column4) from datamart1 group by column1 , column2 ;集約時に、特定の要素だけをカウント

df_tmp\ .groupby('column1')\ .agg({'column2':'nunique'})集約時に、1つのカラムに対して複数の演算を行う

df_tmp\ .groupby('column1')\ .agg({'column2':['sum', 'min', 'max']})演算をする

#python #平均 np.average(nparray, axis = n) #2次元以上のデータの場合、平均の次元によって結果が異なる np.array().mean() #割り算 np.array(nparray1, nparray2)文字列を特定の記号で分割

#リスト形式で取得 str_data.split('特定の文字列')文字列の末尾n字を抽出

str_data[-n]文字列の末尾n字を削除

str_data[:-n]画像データの処理

画像データの読み込み

#python import cv2 cv2.imread('filename.png')#python import PIL PIL.image.open('filename.png')画像データの表示

#python cv2.imshow("image_name", cv2.imread('filename.png')) #"image_name"は任意で設定#python PIL.image.open('filename.png').show()画像データの変換

#python #画像データのnp化 image = PIL.image.open('filename.png') np.array(image)画像の一部の抽出

#python np.array(image)[上ピクセル:下ピクセル, 左ピクセル:右ピクセル]画像に書き加える

#python #四角を書き加える plt.figure() plt.grid(false) cv2.rectangle(np.array(image), (右ピクセル, 上ピクセル), (左ピクセル, 下ピクセル), (255, 255, 255), 4) plt.imshow(np.array(image),cmap='gray',vmin=0,vmax=65555)画像の変換

signal.convolve2DTIF形式の対応

#最後の数字で、何番目の画像を抽出するのかを変える Image.open('~.tif').seek(0)可視化の処理

表示する画像のサイズ

#python plt.figure(figsize = (6,4))表示するグラフの範囲の指定

#python plt.x_lim([右, 左]) plt.y_lim([上, 下])表示する画像を正方形にする

#python aspect = (ax.get_x_lim()[1] - ax.get_xlim()[1]) / (ax.get_y_lim()[1] - ax.get_y_lim()[0]) ax.set_aspect(aspect)背景を透明にする

#python fig.patch.set_alpha(0) #figのみ対応グリッド線の対応

#python #グリッド線を表示させない複数画像の表示

#python #1、subplot、を使う plt.subplot(縦,横,1) plt.plot(~) plt.subplot(縦,横,2) plt.plot(~) ↓ plt.subplot(縦,横,縦×横) plt.show(~) #2、add_subplot、を使う ax1 = plt.figure().add_subplot(縦,横,1) ax1 = plot(~) ↓ plt.show() #3、subplots、を使う fig, axes = plt.subplots(~, figsize=(6,4)) #fig、は使わない axes[1].plot日本語を表示する

#python #ライブラリを使って処理モデリング

メソッド対応表_コーディング一般

時間データの処理

処理時間の計算

#python import time #処理の初め time_start = time.time() #処理の終わり time_end = time.time() print(time_end-time_start)日時データを、文字型から時間型に変換

import datetime from dateutil.relativedelta import relativedelta date_datetime = datetime.datetime.strptime('2020-05-24', '%Y-%m-%d')日時データを、文字型から時間型に変換

import datetime from dateutil.relativedelta import relativedelta datetime.datetime.strftime(date_datetime, '%Y-%m-%d')日時データの差分

date_datetime + datetime.timedelta(days=7) date_datetime + relativedelta(weeks = 1)曜日の情報を日時データから取得

datetime.weekday(date_datetime)パスの処理

pyファイルから関数の読み込み

#python #ディレクトリ"src"以下のファイルから関数を読み込む import sys sys.path.append('src/') from filename.py import func_nameWindowsサーバー上のデータを読む

#python import pathlib filepath = r'パス_ファイル名.csv' read_file = pathlib.WindowPath()特定のディレクトリのファイルを抽出

import glob glob.glob('path/*')ファイルの読み込み、保存

ファイルの読み込み

#python_pandas #dfの読み込み pd.DataFrame(data,columns=[column1,column2]) pd.read_csv('filename')#python_numpy #npz の読み込み np.load(filename)ファイルの保存

#python_pandas #dfの読み込み pd.DataFrame().to_csv('filename', index=False)#python_numpy #npz の保存 np.savez(pathname, filename1 = np.array('1'), filename2 = np.array('2'))#python_matplotlib #画像の保存 plt.savefig('filename')#python_sklearn #モデルの保存 import sklearn import pickle reg = sklearn.LinearRegression().fit(x,y) with open('filename.pickle', mode = 'wb', as f pickle.dump(reg, f)イテレーションの処理

複数要素のイテレーション

#zip for i_column1, i_column2 in zip(df_tmp.column1, df_tmp.column2): #itertools for i,j in permutations(i,j): 順列 combinations(i,j): 組み合わせ products(i,j): 直積イテレーションの番号を入れる

for i in enumerate(df_tmp.column):関数・クラスについて

関数

#def、を使用 def_func_name(parameter1, parameter2): 処理 return 戻り値 #lambda、を使用 lambda parameter: 戻り値の式(parameter) #lambda、を使用_一行で表現 (lambda parameter: 戻り値の式(parameter))(parameter_instance)クラス

- 投稿日:2020-05-26T21:55:16+09:00

ゼロから始めるLeetCode Day37「105. Construct Binary Tree from Preorder and Inorder Traversal」

概要

海外ではエンジニアの面接においてコーディングテストというものが行われるらしく、多くの場合、特定の関数やクラスをお題に沿って実装するという物がメインである。

その対策としてLeetCodeなるサイトで対策を行うようだ。

早い話が本場でも行われているようなコーディングテストに耐えうるようなアルゴリズム力を鍛えるサイト。

せっかくだし人並みのアルゴリズム力くらいは持っておいた方がいいだろうということで不定期に問題を解いてその時に考えたやり方をメモ的に書いていこうかと思います。

前回

ゼロから始めるLeetCode Day36「155. Min Stack」今はTop 100 Liked QuestionsのMediumを解いています。

Easyは全て解いたので気になる方は目次の方へどうぞ。Twitterやってます。

問題

105. Construct Binary Tree from Preorder and Inorder Traversal

難易度はMedium。

Top 100 Liked Questionsからの抜粋です。

前回でEasyが全て解き終わったので今回からはMediumを解いていきます。問題としては、木の構造として、

inorderとpreorderが引数として与えられるので、それらを元に二分木を構築するようなアルゴリズムを書いてください、というものです。preorder = [3,9,20,15,7]

inorder = [9,3,15,20,7]

Return the following binary tree:3 / \ 9 20 / \ 15 7解法

# Definition for a binary tree node. # class TreeNode: # def __init__(self, val=0, left=None, right=None): # self.val = val # self.left = left # self.right = right class Solution: def buildTree(self, preorder: List[int], inorder: List[int]) -> TreeNode: if not preorder or not inorder: return None preordersIndex = preorder[0] Tree = TreeNode(preordersIndex) inordersIndex = inorder.index(preordersIndex) Tree.left = self.buildTree(preorder[1:inordersIndex+1],inorder[:inordersIndex]) Tree.right = self.buildTree(preorder[inordersIndex+1:],inorder[inordersIndex+1:]) return Tree # Runtime: 216 ms, faster than 33.07% of Python3 online submissions for Construct Binary Tree from Preorder and Inorder Traversal. # Memory Usage: 87.7 MB, less than 13.16% of Python3 online submissions for Construct Binary Tree from Preorder and Inorder Traversal.再帰で解きました。TreeNodeのroot部分は固定になるので先に代入しておき、あとは

Treeを左と右に分けて再帰で代入し続けました。ちなみに、こうやって書くよりも短く書かれていたのがdiscussにあったのでこちらも載せておきます。

# Definition for a binary tree node. # class TreeNode: # def __init__(self, val=0, left=None, right=None): # self.val = val # self.left = left # self.right = right class Solution: def buildTree(self, preorder: List[int], inorder: List[int]) -> TreeNode: if inorder: ind = inorder.index(preorder.pop(0)) root = TreeNode(inorder[ind]) root.left = self.buildTree(preorder, inorder[0:ind]) root.right = self.buildTree(preorder, inorder[ind+1:]) return root # Runtime: 164 ms, faster than 49.71% of Python3 online submissions for Construct Binary Tree from Preorder and Inorder Traversal. # Memory Usage: 52.2 MB, less than 60.53% of Python3 online submissions for Construct Binary Tree from Preorder and Inorder Traversal.読みやすい上に速い・・・!

この解答を載せている人はどの問題でも大体簡潔なコードをPythonで書いているのでとても参考になります。Easyまでは一つの要素についての処理ができれば大体解けていたのですが、Mediumだと二つ以上の要素を上手く処理することを求められるイメージですね。

もっと精進せねば。他にもdiscussをもうちょっと読み込んでみようと思います、お疲れ様でした。

- 投稿日:2020-05-26T21:53:32+09:00

【Python】平衡二分木が必要な時に代わりに何とかするテク【競プロ】

※この記事は説明の都合上AtCoderで出題された問題に関するネタバレが含まれています。ご了承ください。

はじめに

平衡二分(探索)木というデータ構造があります。(Wikipedia)

名前 操作 計算量 insert(x)要素 $x$ の挿入 $O(\log N)$ erase(x)要素 $x$ の削除 $O(\log N)$ find(x)要素 $x$ の検索 $O(\log N)$ などの操作が可能で、C++では

std::setやstd::map等の連想配列の実装に用いられています。

このstd::set,std::mapというのは優れもので、標準ライブラリ中のデータ構造でありながら

lower_bound(x): $x$ 以上の最小の要素upper_bound(x): $x$ 以下の最大の要素を$O(\log N)$で検索することができます。内部的に常にソートされているので二分探索ができる、と考えると分かりやすいかと思います。この手軽さゆえに、競技プログラミングの問題の解説に

「……よって、平衡二分木(C++ではsetなど)を使うことで解くことができます。」

と書かれていることがしばしばあります。

残念ながら、Pythonにはそのような組み込みのデータ構造が存在しないため、解説の通りにコードを組むことができません。そこで本記事では、平衡二分木が欲しい場面で代用できる(ある程度汎用的な)手法をいくつか紹介したいと思います。

扱う問題

ABC128-E Roadwork を題材として使用します。(問題リンク)

解説にも書かれているように、この問題は

クエリ 操作 insert(x)集合に要素 $x$ を追加 erase(x)集合から要素 $x$ を削除 minimum()集合内の最小の要素を検索 というクエリをこなす問題です。最小の要素は、充分小さな数を

-INFとしてlower_bound(-INF)を計算すればよいので、まさに平衡二分木の出番、という問題です。解決法1: 平衡二分木を作る

身も蓋もないですが、平衡二分木がないなら自分で作ればよいのです。

幸いにも自作の平衡二分木ライブラリを公開してくれている方が何人もいらっしゃるので、自力で実装するのは難しい……という方でも簡単に使うことができます。大感謝ですね。ただし、自作の複雑なデータ構造は往々にして最適化が働きづらく、定数倍はかなり重くなります。そのため、せっかく平衡二分木を用意したのにTLE、となってしまうことが少なくありません。

平衡二分木を使わずに、平衡二分木と同じ操作はできないでしょうか?補足:

AVL木、実はedamatさん(@edamat1 )がPypy用に書き直してくれた(再帰をなくしたりしてくれた)のがあり、そちらだと割と通るそう

— じゅっぴー (@juppyjappy) May 26, 2020

解決法2: BIT(またはセグメント木)

おそらくこれが一番汎用的な手法かと思います。それぞれのデータ構造を知らない人は調べてください。実装は大差がないため、ここではBITを用いることとします。BITの配列を $B[0], B[1], ..., B[i], ...,$ という形で表します。

先述した平衡二分木に対する操作を、以下のように対応付けて考えます。

クエリ 操作 insert(x)$B[x]$ に $1$ を加算 erase(x)$B[x]$ に $-1$ を加算 minimum()$\sum_{i=0}^x B[x] - \sum_{i=0}^{x-1} B[x]$ lower_bound(x)$s = \sum_{i=0}^{x-1} B[x]$ とし、累積和が初めて $s$ を超える位置を二分探索 こうすると、平衡二分木と同様にこれらの操作をすべて$O(\log N)$で行うことができます。二分探索は単純に実装すると $O(\log^2 N)$ となってしまいますが、セグ木上の二分探索と同じ手法により$O(\log N)$に落とすことができます。(参考リンク)

挿入する要素 $x$ の範囲が $0 \leqq x \leqq 10^6$ 程度であれば、このサイズのBITを構築すればそれでOKですが、今回は挿入する最大の要素が $10^9$ 程度であるので、圧倒的にMLEします。

解決策2.5: 座標圧縮 + BIT(またはセグメント木)

今回の問題はオフラインクエリであり、最初の段階で将来挿入する値がすべてわかります。そこで、これらの値を全てまとめて昇順にソートし、新たに $0, 1, 2, ...$ と番号を振りなおします。(詳しくは「座標圧縮」と検索してください )要素の個数は最大で $2×10^5$ 個であるので、新たに割り振った番号の最大値も $2×10^5$ です。よってこのサイズのBITを用意すれば、MLEすることなく解くことができます。

提出コード(手持ちのライブラリでは

lower_bound(x)の定義が「累積和が $x$ 以上になる最小のindex」だったのでそれに合わせて実装しています。)TLEしてしまいました……

解決法3: 優先度付きキュー

ところで、

eraseクエリがない場合を考えてみましょう。

クエリ 操作 insert(x)集合に要素 $x$ を追加 minimum()集合内の最小の要素を検索 これならば、Pythonにある優先度付きキューのライブラリを用いることで実現できます。

しかし、eraseクエリを行うには、先頭から線形探索して削除する必要があり、 $O(N)$ かかってしまいます。これを解決するために、優先度付きキューを二本使った以下のようなテクニックが使えます。

まず、$p, q$ という二つの優先度付きキューを用意して、以下のように対応付けます。import heapq p = list() q = list() def insert(x): heapq.heappush(p, x) return def erase(x): heapq.heappush(q, x) return def minimum(): while q and p[0] == q[0]: heapq.heappop(p) heapq.heappop(q) return p[0](これは疑似コードであり、変数のスコープの関係でこのままでは動作しません。)

このアイデアの核は、「現時点での最小値を削除するのでないかぎり、

eraseを後回しにしてもminimumの結果には影響しない」ということです。そこで、eraseクエリは後回し用の優先度付きキュー $q$ に突っ込んでおきます。

minimumの結果を返す際、現時点での最小値 $x$ が削除する必要のあるものかどうかを確かめます。 $x$ が $q$ の中に存在しているとしたら、先頭にあるはずです。よって、 $p$ と $q$ の先頭の要素が等しい場合は、後回しにしていたeraseを行う必要があります。こうして更新された最小値もまた削除する必要があるかもしれないので、削除されていない本当の最小値が確定するまでこれを繰り返します。

一見この操作には $O(N\log N)$ かかるようにも思えますが、各要素は最大1回しか削除されないため、償却 $O(\log N)$ で計算可能です。(償却計算量についてはこちらをご覧ください)

ちなみに $q$ は優先度付きキューではなくsetでも大丈夫です。また、以上の議論では不当な

erase(そもそも存在しない要素を削除しようとすること)が存在しないと暗に仮定していましたが、別途「現時点で各要素 $x$ がいくつあるか」を格納した辞書を用意することで、クエリが来た時点でそれが不当かどうか判断することもできます。今回は問題の性質上不当なクエリは存在しません。提出コード

間に合いました!無事ACです。解決法4: setでゴリ押し

要素の追加、削除はsetを使えば $O(1)$ で行えます。ただし、

minimumには $O(N)$ かかってしまいます。

そこで、各クエリあたりの計算量を抑えるのではなく、クエリ計算する回数自体をを減らすことを考えてみます。発想としては先ほどの「後回しにしてもよい」に近いです。以下の疑似コードをご覧ください。S = set() curmin = 10**18 # 現時点での最小値 flag = False # 更新が必要か def insert(x): S.add(x) if x <= curmin: curmin = x flag = False return def erase(x): S.remove(x) if x == curmin: flag = True return def minimum(): if flag: curmin = min(S) flag = False return curminコードを見てもらえばなんとなく分かるとは思いますが、なるべく結果を保存しようとしています。このように無駄な

minimumの計算を最大限抑えることで、クエリ一回当たりの平均計算量をなるべく抑えることができます(計算回数はテストケースに依存します)。意地悪なケースではほとんど改善されませんが、完全にランダムなケースでは実行時間が大幅に短くなることもあります。提出コード

優先度付きキューの解法より速くなりました!驚き番外編: 別の解法を考える

視点を変えることで別の解法が適用できる場合があります。この問題では二分探索を上手に使う解法があったりします。

おわりに

紹介した各手法は、平衡二分木の代用としてだけではなく、他の問題を解くうえで計算量を削減するヒントにもなるテクニックです。なんとなく覚えておくと役に立つときが来るかもしれません。

- 投稿日:2020-05-26T21:40:31+09:00

Auteoencoderによる,MNISTを用いた異常検知 (PyTorch)

概要

皆様,こんにちは.

漸く緊急事態宣言が解除されましたが,まだまだ予断を許さない状況が続いていますね..

まだまだ私も,家にこもりっぱなしの生活が続きそうです.さて,今回は,シンプルなAutoencoderを用いてMNISTに対する異常検知プログラムを実装し,検証していきたいと思います.具体的には,以下のようなモデルとなります.

(当記事でご理解いただけるのは,Autoencoderと異常検知の基本的な流れ,PyTorchを用いたMNISTの異常検知の流れとその検証結果です.)

QiitaにはすでにMNISTを使った異常検知の記事が何件か掲載されております.

なので,じゃあこの記事の需要はどこに?って話になるのですが,実はPyTorchで実装している点が他と違う点と考えています.ググると良くでてくるのはKerasを使った実装例なんですが,僕は最近PyTorchに乗り換えた身なので,PyTorchの実装ないかなーとあさっていたんですが,見つからなかったので自分で実装した次第です.それでは解説に参ります.

なお,今回の実装したコードはすべてこちらで公開しております.

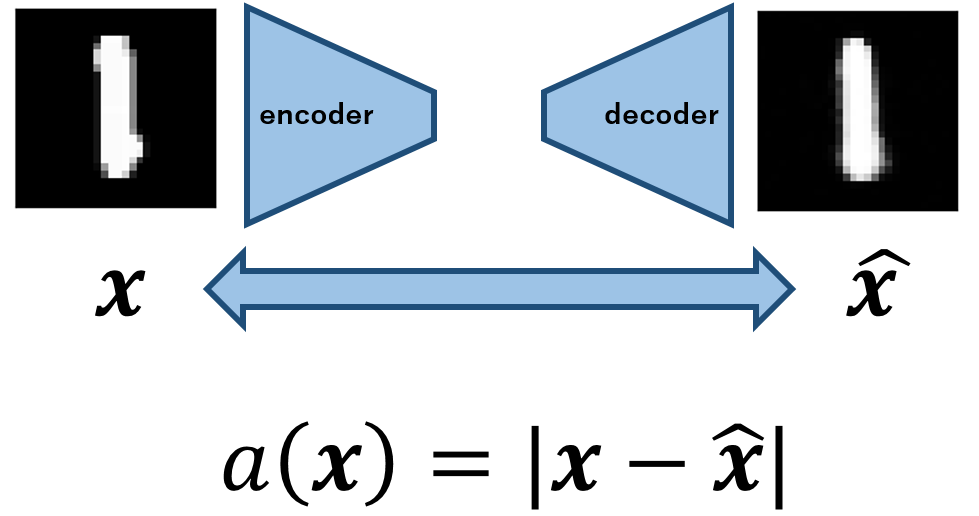

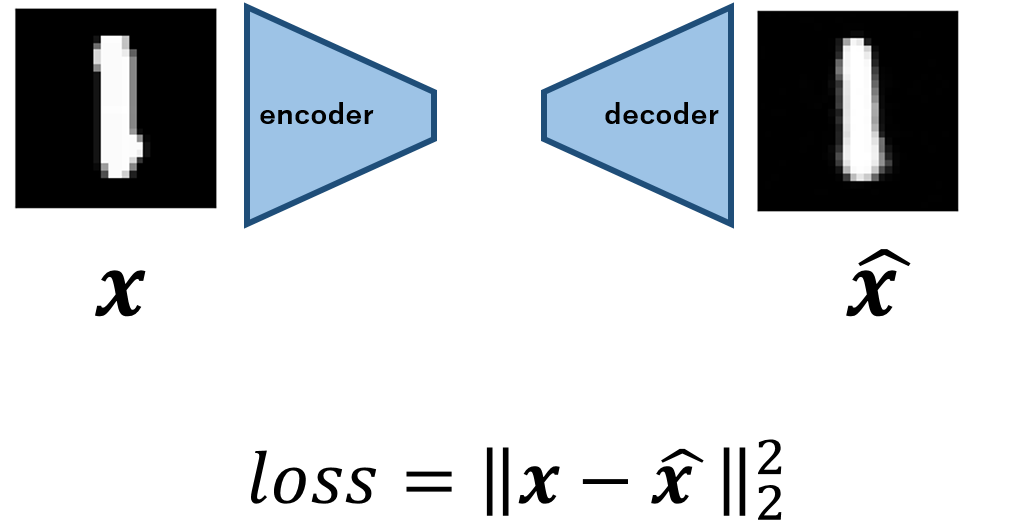

Autoencoderと異常検知

Autoencoderがどのように異常検知タスクに応用されるのか,簡単に振り返ります.(ご存じの方は実装以降の章をご覧ください)

Autoencoderについて

Autoencoderの発想はいたってシンプルで,画像などが存在する高次元データをencoderを用いて潜在変数へと符号し,decoderを用いて画像を復号するモデルです.

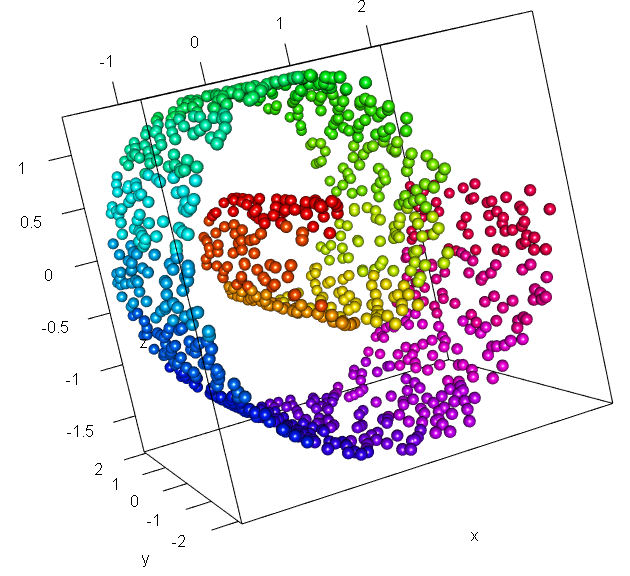

潜在空間へと写像するメリットは何?となってくるわけですが,これは多様体仮説に基づいています.以下の分布をご覧ください.

引用元:こちら

上記はスイスロール分布と呼ばれるものです.画像では三次元ですが,高次元データの例だとお考え下さい.よく見ると,かなりデータが疎な部分が存在しているのがわかるかと思います.これを二次元に写像する(平面に引き延ばすようなイメージ)ことができれば,元の分布を低次元空間で表現可能と推測できます.より一般的に言えば,高次元空間に存在するデータは低次元多様体としてとらえられる,これを多様体仮説と呼びます.

Autoencoderの話に戻ると,encoderによって,高次元空間から低次元の潜在空間へと写像されるのでした.つまり,画像のような高次元のデータの「特徴」なるものを抽出し,潜在変数として扱っていることになります.

この低次元の「特徴」から,元のデータを復号するのです.異常検知への応用

このAutoencoderの枠組みは,異常検知でしばしば応用されます[1].

異常検知の目的は,入力データに対してモデルが「正常」か「異常」かどうかを認識することにあります.この問題設定は,よく用いられる教師あり学習でのパターン認識の枠組みですが,残念ながら異常検知が実際に応用される工場など(外観検査)の多くは,異常データが集まらないのが普通です.

そのため,パターン認識のような教師ありのアプローチは適用できません.

しかし,一般に工場などの現場では,大量に「正常」なデータが取得できます.これを活用して,「異常検知」に落とし込むために,Autoencoderが登場します.

上記までで説明した通り,Autoencoderでは高次元のデータの分布から,特徴を抽出して低次元の潜在空間へと写像することができます.つまり,大量の正常データを用いてモデルを学習することで,正常なデータの特徴を獲得できます.このことから,「正常」なデータをモデルに入力すれば,もちろんdecoderは元の入力を復号できるでしょう.しかし「異常」なデータが入力されたとき,これは異常なデータを表現できる特徴を獲得していないので,うまく復号することができません.

このトリックを用いて異常検知が行われます.具体的には,入出力間で差分をとり,それを異常度として計算することで異常が検知できます.

なお,実際の異常検知への応用事例は,大半が「教師なし」もしくはわずかな異常データを活用する「半教師あり」の二つが用いられます.次に,実際にMNISTの実装と実験を確認することで,より理解を深めていただければと思います.

実装・MNISTのロード部分

MNIST(手書き数字のデータセット)を用いて異常検知をさせます.今回は,MNISTの有する0~9のうち,「1」のラベルがついたものを正常データとして学習します.

そして,「9」のラベルがついたものを異常データとして,これを検知できるかどうかを検証していきます.まず,PyTorchのdatasetクラスのMNISTモジュールを用いることで,簡単にMNISTデータをロードできます.

しかしこのままでは,0~9すべてのデータが存在していますので,これを任意のラベルのものにのみ絞る作業が必要です.以下のようなクラスを定義しました.main.pyclass Mnisttox(Dataset): def __init__(self, datasets ,labels:list): self.dataset = [datasets[i][0] for i in range(len(datasets)) if datasets[i][1] in labels ] self.labels = labels self.len_oneclass = int(len(self.dataset)/10) def __len__(self): return int(len(self.dataset)) def __getitem__(self, index): img = self.dataset[index] return img,[]初期化メソッドでは,引数として与えた任意のラベルのlistに該当するデータのみを,クラス内の変数として渡しています.後は通常のDatasetクラスと同じ挙動ですね.

肝心のAutoencoderは,以下のように定義しています.

main.pyclass Autoencoder(nn.Module): def __init__(self,z_dim): super(Autoencoder, self).__init__() self.encoder = nn.Sequential( nn.Linear(28 * 28, 256), nn.ReLU(True), nn.Linear(256, 128), nn.ReLU(True), nn.Linear(128, z_dim)) self.decoder = nn.Sequential( nn.Linear(z_dim, 128), nn.ReLU(True), nn.Linear(128, 256), nn.ReLU(True), nn.Linear(256, 28 * 28), nn.Tanh() ) def forward(self, x): z = self.encoder(x) xhat = self.decoder(z) return xhatそれぞれ三層のシンプルなものです.

学習は入出力間のMSEをとり,これを最小化することで入力を再構成するように学習されます.

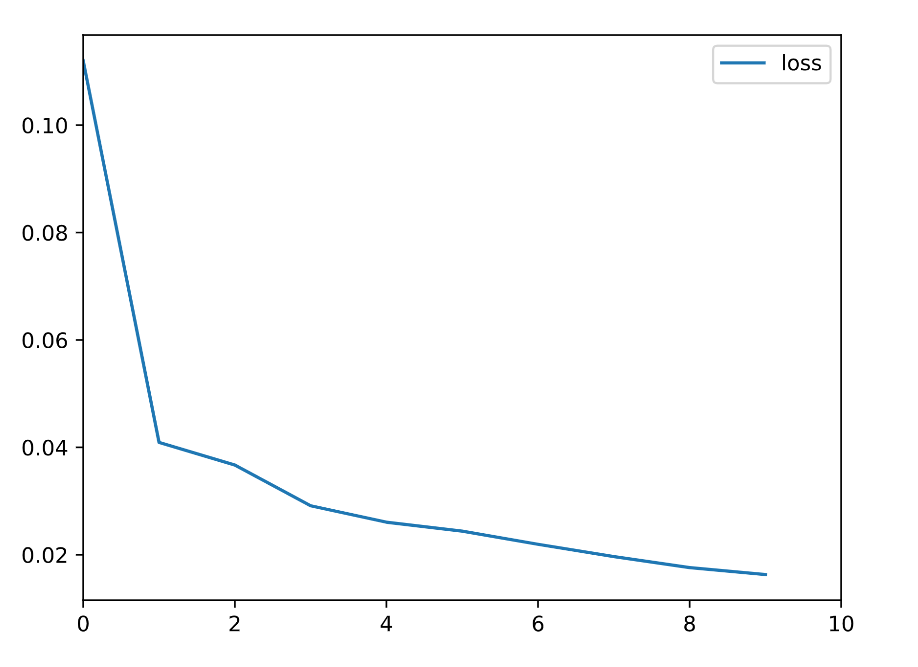

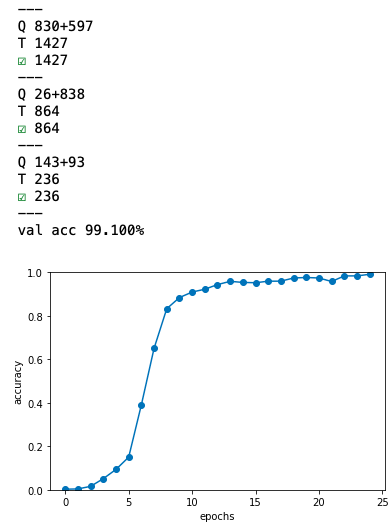

では,実験に入ります.実験・考察

上記のように,学習データは「1」の画像のみで,約6,000枚の画像データを学習します.

テストデータは「1」と「9」のデータを混ぜ,「9」を正しく異常と判別できるかを確認します.

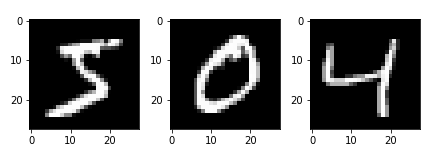

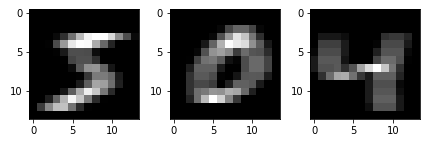

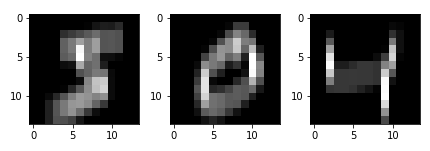

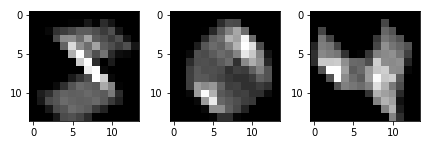

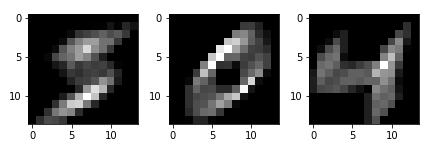

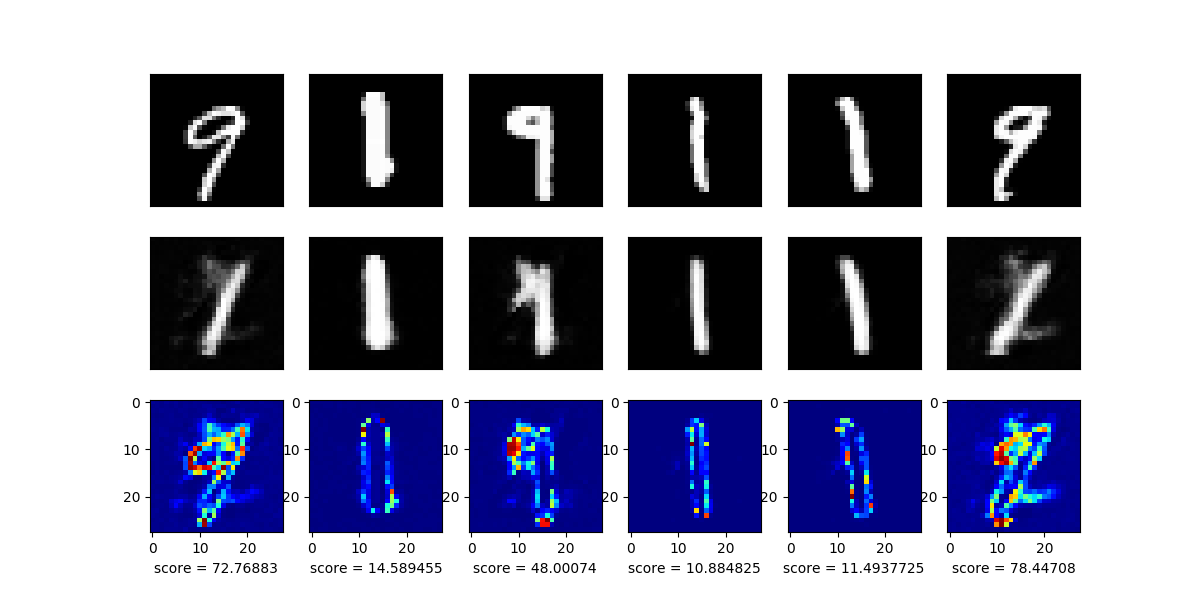

なお,異常度の定義は入出力間の差の絶対値を用います.モデルの入力(上段)と,その出力(中段),さらにその差分画像(下段)を以下に示します.

目論見通り,学習した「1」の画像はうまく再構成できているのがわかりますが,異常データとして混ぜた「9」のデータはうまく再構成できていないのがわかりますね.

今回はシンプルな全結合層のみのモデルでしたが,うまくいった印象です.また,下段のscoreに着目すると,異常データが入力された際には値が大きくなっていることがわかります.

実際には異常度に閾値を設けることで,異常検知を行います.閾値の設け方は,専門家による設計だよりであることがほとんどです.まとめ

今回は,PyTorchを用いてMNISTによる教師なし異常検知を実装し,検証しました.

また,Autoencoderを用いた異常検知の基本的な流れについても解説しました.

今回の記事は,技術的な新規性という観点では微妙になってしまいましたが,PyTorchによるMNISTの異常検知という意味では需要があるかと思ってます(そう思っているのは僕だけかもしれませんが(笑))

記事が冗長になるのを恐れて,異常検知性能の定量的評価(AUROCなど)までは手をつけませんでしたが,近いうちにまとめたいと思います.

同時に,GANによる異常検知のframeworkの検証も行いたいところです.

最近では,Autoencoderからさらに発展して,AnoGAN,EfficientGAN,AnoVAEGANなど,多様なGANを活用した異常検知のframeworkが登場し,次々にSOTAを獲得しています.

今後の動向にさらに期待できますね.参考文献

- 投稿日:2020-05-26T21:31:48+09:00

【EC2】seleniumを使ってサックっとスクレイピング入門(テキスト抽出と画面キャプチャ)

【EC2】seleniumを使ってサックっとスクレイピング入門

EC2上でpythonのseleniumを使って指定したURLの要素を抜き出すまでの流れまとめ。

やること

- chromeドライバーのインストール

- chromeのインストール

- seleniumのインストール

- 日本語フォントのインストール

- 指定したURLのテキストを抜き出す(text.py)

- 指定したURLの画面キャプチャを取得(capture.py)

前提

・sshを使ってEC2インスタンスに接続済み。

・python3インストール済み。1.chromeドライバーのインストール

①ChromeDriverのオフィシャルページからDLしたいバージョンのDLページに移動。

②linux64用のリンクのアドレスをコピー。

③DLし解凍

#tmpディレクトリに移動 $ cd/tmp/ #chromedriverをダウンロード(URLはコピペ) $ wget https://chromedriver.storage.googleapis.com/83.0.4103.39/chromedriver_linux64.zip #解凍 $ unzip chromedriver_linux64.zip #解凍したファイルを /user/bin配下に移動 $ sudo mv chromedriver /usr/bin/chromedriver2.chromeのインストール

#1文でchromeインストール完了 $ curl https://intoli.com/install-google-chrome.sh | bash Complete! <-インストール成功 Successfully installed Google Chrome! #ファイル名を変更 $ sudo mv /usr/bin/google-chrome-stable /usr/bin/google-chrome #バージョンの確認 $ google-chrome --version && which google-chrome Google Chrome 83.0.4103.61 <- --versionの実行結果 /usr/bin/google-chrome <- whichの実行結果3.seleniumのインストール

$ pip3 install selenium

4.日本語フォントのインストール

$ sudo yum install ipa-gothic-fonts ipa-mincho-fonts ipa-pgothic-fonts ipa-pmincho-fontsインストールしておかないと、画面キャプチャした際に文字化けする。

5.指定したURLのテキストを抜き出す(text.py)

①ユーザーフォルダにtext.pyファイルを作成

$ cd ~ $ touch text.py $ vi text.py②vimエディタが立ち上がるので以下をコピペ。

└ 「i」キーで挿入モードに入る。

└ コピペは「shift+ins」(もしくは右クリックでpasteを選択)#-*- coding: utf-8 -*- from selenium import webdriver from selenium.webdriver.chrome.options import Options options = Options() options.headless = True driver = webdriver.Chrome(options=options) #URLの指定 driver.get("https://www.google.co.jp/") #スクレイピングする要素を指定 element_text = driver.find_element_by_id("hptl").text print(element_text) driver.quit()③貼り付けが終わったら下記でvimエディタを保存し終了。

esc + :wq + Enter④作成したファイルを実行

$ python3 text.py #下記が表示されれば成功 Googleについて ストア

googleトップの右上のテキストをスクレイピング完了。

指定したURLの画面キャプチャを取得(capture.py)

①ユーザーフォルダにcaputure.pyファイルを作成

$ cd ~ $ touch capture.py $ vi capture.py②vimエディタが立ち上がるので以下をコピペ。

└ 「i」キーで挿入モードに入る。

└ コピペは「shift+ins」(もしくは右クリックでpasteを選択)#-*- coding: utf-8 -*- from selenium import webdriver from selenium.webdriver.chrome.options import Options options = Options() options.headless = True #キャプチャする画面サイズを指定 options.add_argument('--window-size=1280,1024') driver = webdriver.Chrome(options=options) #URLを指定 driver.get("https://www.google.co.jp/") #キャプチャのファイル名と拡張子を指定 driver.save_screenshot('googletop.png') driver.quit()③貼り付けが終わったら下記でvimエディタを保存し終了。

esc + :wq + Enter④作成したファイルを実行

$ python3 capture.py #同一ディレクトリに下記ファイルができていれば成功 $ ls googletop.png

割とシンプルにスクレイピングができる。

あとはURL変えたり、抜き出す要素を変更したりカスタマイズ。

- 投稿日:2020-05-26T21:29:20+09:00

[Python] TkinterでYoutube Downloaderを作ってみた。

1.はじめに

TkinterとPytubeを用いて、Youtubeの動画をダウンロードするGUIプロるグラムを作ってみました。

2.1.pytyube

Pytubeの設置方法、使い方は下記のリンクを参考にしてください。

https://python-pytube.readthedocs.io/en/latest/

2.2.Threading導入

GUIの応答性を維持しながら、Freezeするために、Multi-threadingを導入します。

2.2.1. 生成順番

下記の順番で、Threadを設計します。

StartボタンのCall Back関数 → Thread生成メソッド → 実行メソッドfrom threading import Thread #Call Back関数 def click_me(self): self.create_thread() #Thread生成メソッド def create_thread(self): self.run_thread = Thread( target=self.method_in_a_thread ) self.run_thread.start() print(self.run_thread) #実行メソッド def method_in_a_thread(self): print('New Thread is Running.') self.get_youtube( self.URL_name.get(), self.Folder_name.get())2.2.2. 呼び出し

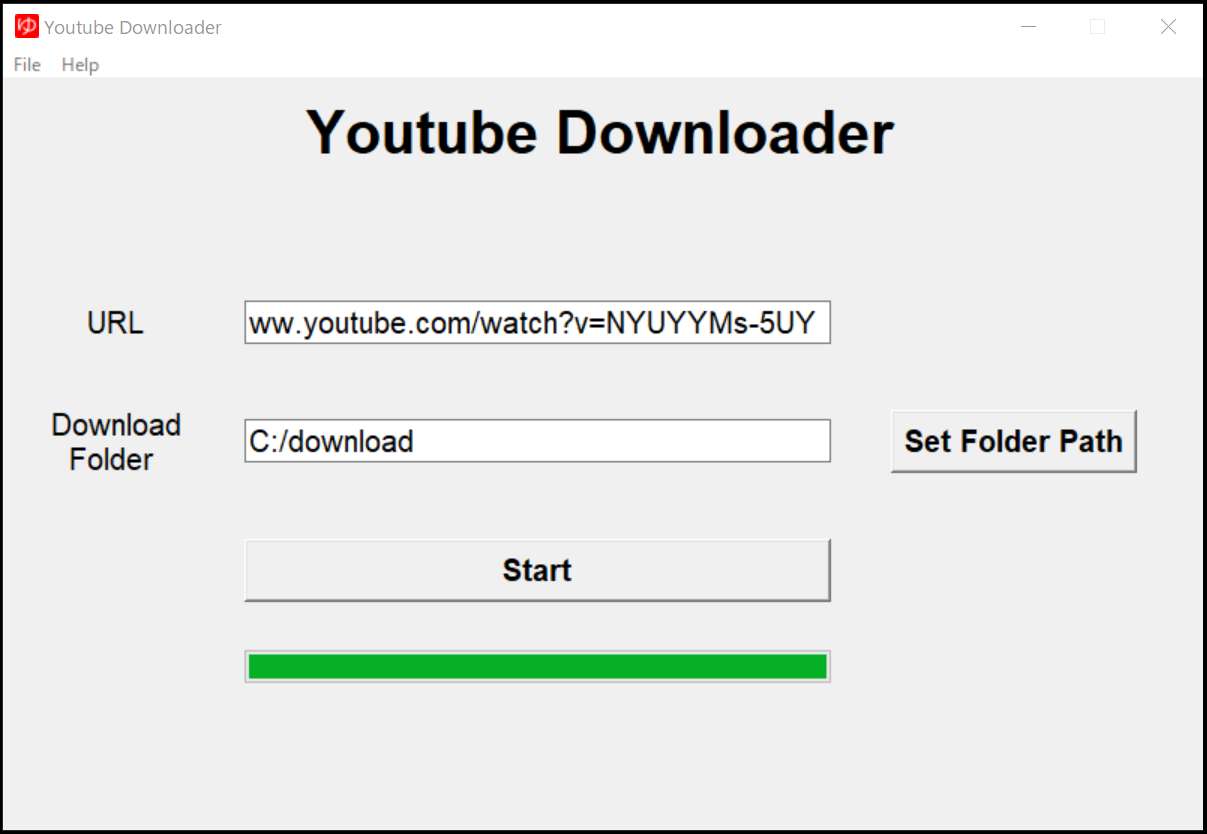

self.btn_Start = tk.Button(self.frame_form, text = 'Start') self.btn_Start.configure( font= self.font02 ) self.btn_Start.grid( column=1, row=2, padx=20, pady=20, sticky= tk.W + tk.E ) self.btn_Start.configure( command = self.click_me)3.使い方

ダウンロードするYoutube動画のURLを入力し、ダウンロードするフォルダーを指定します。

そして、Startボタンを押します。

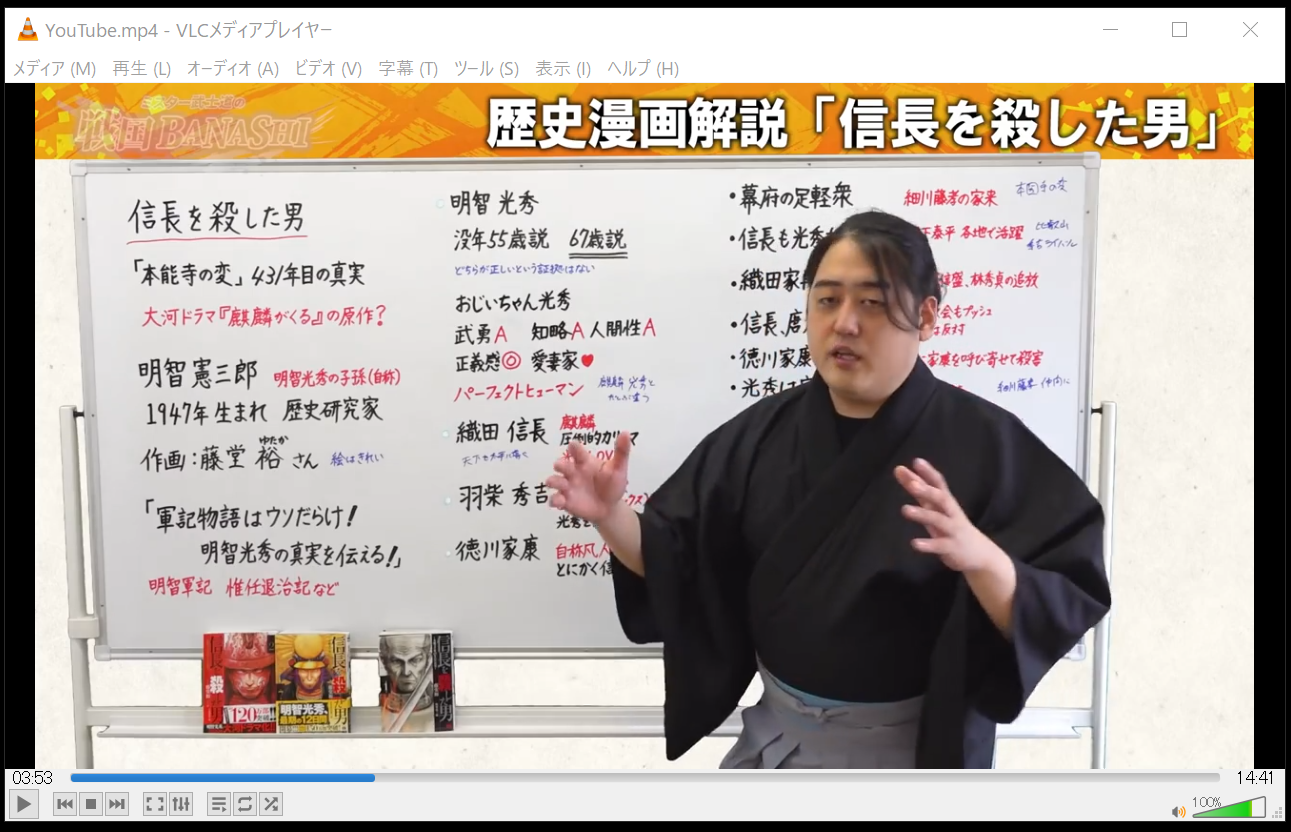

最近、NHK大河ドラマ「麒麟がくる」の解説動画で躍進中のMr.武士道さんの動画を例として挙げます。

https://www.youtube.com/watch?v=NYUYYMs-5UY

ダウンロードした後、プレーヤーで再生する様子です。

4.まとめ

- YoutubeダウンロードにPytubeというモジュールを利用。

- Tkinterを利用し、GUI化する。

- GUIの応答性を維持するため、Multi-threadingを導入。

5.コード

GUI_youtube.pyfrom pytube import YouTube import tkinter as tk from tkinter import Menu from tkinter import messagebox as msg from tkinter import font from tkinter import filedialog from tkinter import ttk import os from time import sleep from threading import Thread class Application(tk.Frame): def __init__(self,master): super().__init__(master) self.pack() self.master.geometry("800x500") self.master.title("Youtube Downloader") self.master.resizable(False, False) # --------------------------------------- # Favicon # --------------------------------------- self.iconfile = "./favicon.ico" self.master.iconbitmap(default=self.iconfile) self.create_widgets() def create_widgets(self): # --------------------------------------- # font # --------------------------------------- self.font01 = font.Font(family="Helvetica", size=15, weight="normal") self.font02 = font.Font(family='Helvetica', size=15, weight='bold') self.font03 = font.Font(family='Helvetica', size=30, weight='bold') # --------------------------------------- # Menu # --------------------------------------- self.menu_bar = Menu( self.master ) self.master.config( menu=self.menu_bar ) self.file_menu = Menu( self.menu_bar, tearoff=0 ) self.file_menu.add_command( label='Exit', command=self._quit ) self.menu_bar.add_cascade( label='File', menu=self.file_menu ) # Add another help menu self.help_menu = Menu( self.menu_bar, tearoff=0 ) self.help_menu.add_command( label='About', command=self._msgBox ) # Display messagebox when clicked self.menu_bar.add_cascade( label='Help', menu=self.help_menu ) # --------------------------------------- # Main Label # --------------------------------------- self.lbl_main = ttk.Label(self.master, text = 'Youtube Downloader', font=self.font03) self.lbl_main.place(relx = 0.25, rely = 0.02) # --------------------------------------- # Frame : URL Input Form, Downloader Folder # --------------------------------------- self.frame_form = tk.Label(self.master) self.frame_form.place(relx = 0.01 , rely = 0.25, height = 400 , width= 780 ) # --------------------------------------- # URL Input Form # --------------------------------------- self.lbl_URL = ttk.Label(self.frame_form, text = 'URL') self.lbl_URL.configure(font=self.font01) self.lbl_URL.grid(column=0, row=0, padx = 20, pady= 20) self.URL_name = tk.StringVar() self.ent_URL = ttk.Entry(self.frame_form, textvariable = self.URL_name) self.ent_URL.configure(width = 35, font= self.font01) self.ent_URL.grid(column=1, row=0, padx = 20, pady= 20) self.ent_URL.focus() # --------------------------------------- # Download Folder # --------------------------------------- self.Folder_name = tk.StringVar() self.lbl_folder = ttk.Label( self.frame_form, text='Download\n Folder' ) self.lbl_folder.configure( font=self.font01 ) self.lbl_folder.grid( column=0, row=1, padx=20, pady=20 ) self.ent_Folder = ttk.Entry(self.frame_form,textvariable = self.Folder_name) self.ent_Folder.configure(width =35,font= self.font01) self.ent_Folder.grid(column=1, row=1, padx=20, pady=20) self.btn_Folder = tk.Button( self.frame_form, text = 'Set Folder Path') self.btn_Folder.configure(font = self.font02) self.btn_Folder.grid(column=2, row=1, padx=20, pady=20, sticky=tk.W + tk.E ) self.btn_Folder.configure( command= self._get_Folder_Path) # --------------------------------------- # Start Button # --------------------------------------- self.btn_Start = tk.Button(self.frame_form, text = 'Start') self.btn_Start.configure( font= self.font02 ) self.btn_Start.grid( column=1, row=2, padx=20, pady=20, sticky= tk.W + tk.E ) self.btn_Start.configure( command = self.click_me) # # --------------------------------------- # Progress Bar # --------------------------------------- self.progress_bar = ttk.Progressbar(self.frame_form, orient='horizontal', length=286, mode = 'determinate') self.progress_bar.grid(column=1, row=3, padx=20, pady=12,sticky=tk.W + tk.E) # --------------------------------------- # Create Callback Functions # --------------------------------------- #Python Treading to prevent GUI freezing. def click_me(self): self.create_thread() def create_thread(self): self.run_thread = Thread( target=self.method_in_a_thread ) self.run_thread.start() print(self.run_thread) def method_in_a_thread(self): print('New Thread is Running.') self.get_youtube( self.URL_name.get(), self.Folder_name.get()) # Display a Message Box def _msgBox(self): msg.showinfo('Program Information', 'Youtube Downloader with Tkinter \n (c) 2020 Tomomi Research Inc.') # Youtube Download Function def get_youtube(self, y_url, download_folder): #Youtube Instance yt = YouTube(y_url) yt.streams.filter(progressive=True ,subtype='mp4' ).get_highest_resolution().download( download_folder ) #progress bar self.progress_bar["maximum"] = 100 for i in range(101): sleep(0.05) self.progress_bar["value"]= i self.progress_bar.update() # Exit GUI cleanly def _quit(self): self.master.quit() self.master.destroy() exit() # Get Folder Path def _get_Folder_Path(self): iDir = os.path.abspath(os.path.dirname(__file__)) folder_Path = filedialog.askdirectory(initialdir = iDir) self.Folder_name.set(folder_Path) def main(): root = tk.Tk() app = Application(master=root)#Inherit app.mainloop() if __name__ == "__main__": main()参考資料

1.pytubeを使ってみよう

2.YouTubeから動画をダウンロードしてくるGUIツール(Python)

3.Threading in Tkinter python improve the performance

- 投稿日:2020-05-26T21:26:19+09:00

Biopython Tutorial and Cookbook和訳(4.1)

Biopythonのチュートリアルを訳する目的と理由:

- 生物の学習

- Biopythonの勉強

- 英語の復習

- 少しでもこの分野に貢献したい

どっちも全くの初心者なので、意味を通じない部分があればぜひご指摘ください。

2日で1節のペースで訳して行きます。

間違いを発見しやすいように英文も一緒に載せます。

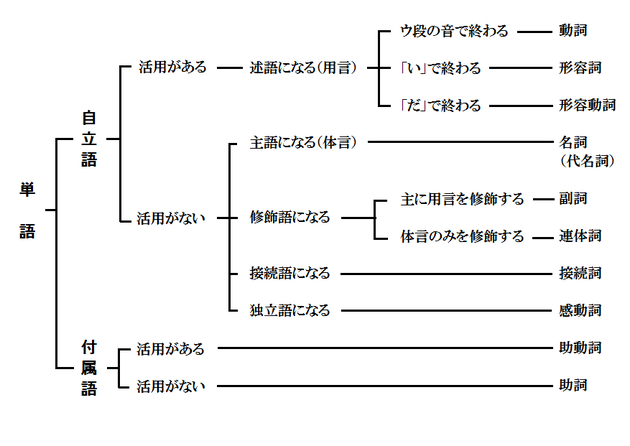

一章を終えたら一つの記事にまとめます。Chapter 4 Sequence annotation objects

Chapter 3 introduced the sequence classes.

chp3はシーケンスクラスを紹介しました。Immediately “above” the Seq class is the Sequence Record or SeqRecord class, defined in the Bio.SeqRecord module.

Seq classの真上(継承の意味?)はSequence Record、あるいはSeqRecordクラス、Bio.SeqRecordモジュール内に定義されています。This class allows higher level features such as identifiers and features (as SeqFeature objects) to be associated with the sequence, and is used throughout the sequence input/output interface Bio.SeqIO described fully in Chapter 5.

このクラスはidentifiersやfeature(SeqFeatureオブジェクト)のようなハイレベルの特徴をシーケンスと結びつける、そしてchap5に紹介するシーケンスのinput/outputインタフェース - Bio.SeqIOに広く使われています。If you are only going to be working with simple data like FASTA files, you can probably(おそらく) skip this chapter for now.

もしあなたがFASTAのようなシンプルなデータしか扱わないなら、この章を飛ばしてもたぶん問題ないでしょう。While this chapter should cover most things to do with the SeqRecord and SeqFeature objects in this chapter,

you may also want to read the SeqRecord wiki page (http://biopython.org/wiki/SeqRecord), and the built in documentation (also online – SeqRecord and SeqFeature):

この章ではSeqRecord や SeqFeature objectsを使って多くのことをこなす必要があり、

SeqRecord wiki pageや関数のドキュメンテーションも参照したほうがいいかもしれないです。>>> from Bio.SeqRecord import SeqRecord >>> help(SeqRecord)4.1 The SeqRecord object

The SeqRecord (Sequence Record) class is defined in the Bio.SeqRecord module.

SeqRecord (Sequence Record)クラスはBio.SeqRecordモジュール内に定義されています。This class allows higher level features such as identifiers and features to be associated with a sequence (see Chapter 3),

and is the basic data type for the Bio.SeqIO sequence input/output interface (see Chapter 5).

このクラスはシーケンスに高いレベルの特徴と修飾子を付ける機能を提供しています。

そして、それはBio.SeqIOシーケンスinput/outputインタフェースの基本のデータとなります(chap5を参照)The SeqRecord class itself is quite simple, and offers the following information as attributes:

SeqRecordクラス自体はとてもシンプルで、以下の情報を属性として使います。.seq

– The sequence itself, typically a Seq object.

.id

– The primary ID used to identify the sequence – a string. In most cases this is something like an accession number.

.name

– A “common” name/id for the sequence – a string. In some cases this will be the same as the accession number, but it could also be a clone name. I think of this as being analogous to the LOCUS id in a GenBank record.

.description

– A human readable description or expressive name for the sequence – a string.

.letter_annotations

– Holds per-letter-annotations using a (restricted) dictionary of additional information about the letters in the sequence. The keys are the name of the information, and the information is contained in the value as a Python sequence (i.e. a list, tuple or string) with the same length as the sequence itself. This is often used for quality scores (e.g. Section 20.1.6) or secondary structure information (e.g. from Stockholm/PFAM alignment files).

.annotations

– A dictionary of additional information about the sequence. The keys are the name of the information, and the information is contained in the value. This allows the addition of more “unstructured” information to the sequence.

.features

– A list of SeqFeature objects with more structured information about the features on a sequence (e.g. position of genes on a genome, or domains on a protein sequence). The structure of sequence features is described below in Section 4.3.

.dbxrefs

- A list of database cross-references as strings..seq

– シーケンス自分自身, 一般的にSeqオブジェクト.

.id

– シーケンスを識別するためのID – 文字列. 多くの場合はアクセッション番号.

.name

– シーケンスの通称 – 文字列. たまにはアクセッション番号かクローンネームとなります('Clone name'が'IR'で始まるクローンが完全長クローンです). GenBank recordの遺伝子座IDに似ています.

.description

– 人間が可読な情報 あるいはシーケンスの意味を表す名前 – 文字列.

.letter_annotations

– (制限された)シーケンスの文字に関する付加情報(辞書型)を利用することで文字ごとのアノテーションを保持します. キーは情報の名前で, 情報は値に含まれます (i.e. リスト、タプルあるいは文字列) シーケンスと同じ長さになります. 品質スコア (e.g. Section 20.1.6) あるいは二次構造情報によく使われます (e.g. from Stockholm/PFAM alignment files).

.annotations

– シーケンス付加情報(辞書型). キーは情報の名前, 値は情報. シーケンスにより多くの付加情報を追加することができます.

.features

– SeqFeature objectsのリスト型でより多くの構造化情報が含まれるシーケンスの特徴データ (e.g. ゲノム上の遺伝子位置情報, あるいはたんぱく質シーケンスのドメイン). Section 4.3では構造化したシーケンスの特徴を言及します.

.dbxrefs

– データベースの相互参照リスト(文字列).

- 投稿日:2020-05-26T21:24:30+09:00

Pythonでドラクエのポーカーを実装してみた

はじめに

今回は前の記事にある山札を利用してドラクエのポーカーを実装してみたいと思います。

通常のポーカーは基本的にplayer同士で行われますが、

- player同士のリアルタイム対戦機能が大変

- ブラフ(はったり)が一切なくなる

- 強いカードと思わせ、相手を降ろして勝つ

- 弱いカードと思わせ、相手により多くのお金を賭けさせる

こういった理由からplayer同士のポーカーではなく、

ドラクエのポーカーのような一人用のゲームを実装していこうと思います。ゲームの流れ

ポーカーで役を作る → ダブルアップゲームでスコアを倍にしていく

というのが基本的な流れです。機能要件

基本

- デッキはポーカー、ダブルアップゲーム共に毎回リセット

- プレイヤーの初期スコアは0

- ポーカー終了後、1ペア以上の役があればダブルアップゲームスタート

- ジョーカーはなし

ポーカー

- 5枚のカードが配られる

- 1枚ずつ 変える or 残す を選択

- 変える を選択したカードを交換

- 交換後の5枚で役の計算

- 役の判定を行い、役に応じてスコア決定

ダブルアップゲーム

- 5枚のカードが配られる(1枚は表向き、4枚は裏向き)

- 4枚の裏向きのカードから表向きのカードよりも強いと思うカードを選択

- 強い場合はスコアが倍、再度ダブルアップゲームに挑戦できる

- 弱い場合はスコアが0、ポーカーから再スタート

役・スコアについて

役名 カードの状態 手札の例 スコア 1ペア 同じ数字のペアが1つ [♣️-4, ♠︎-4, ♦︎-Q, ♠︎-K, ❤︎-5] 50 2ペア 同じ数字のペアが2つ [♣️-4, ♠︎-4, ♦︎-Q, ♠︎-Q, ❤︎-5] 100 3カード 同じ数字3枚 [♣️-4, ♠︎-4, ♦︎-4, ♠︎-Q, ❤︎-5] 200 ストレート 数字が連続している [♣️-3, ♠︎-4, ♦︎-5, ♠︎-6, ❤︎-7] 300 フラッシュ マークが全て同じ [♠︎-3, ♠︎-4, ♠︎-5, ♠︎-Q, ♠︎-9] 400 フルハウス 同じ数字3枚 + 1ペア [♠︎-3, ♠︎-4, ♠︎-5, ♠︎-Q, ♠︎-9] 500 フォーカード 同じ数字4枚 [♠︎-4, ♦︎-4, ♠︎-4, ♣️-4, ❤︎-9] 1000 ストレートフラッシュ フラッシュ かつ ストレート [♠︎-4, ♠︎-5, ♠︎-6, ♠︎-7, ♠︎-8] 2000 ロイヤルストレートフラッシュ フラッシュ かつ ストレート [♠︎-10, ♠︎-J, ♠︎-Q, ♠︎-K, ♠︎-A] 10000 ※ 今回はジョーカーなしで実装するのでファイブカード、

ドラクエだと一番上のロイヤルストレートスライム(マークがスライム)はなしです!実装

下記のクラスを用意しました。他にも良い方法はあると思います。。

Cardクラス・Deckクラス

こちらの記事で作成したものをそのまま利用しました。

Playerクラス