- 投稿日:2020-04-07T23:40:24+09:00

テレワークで役立つAmazon Workspacesをちゃんと監視できるのか?

概要

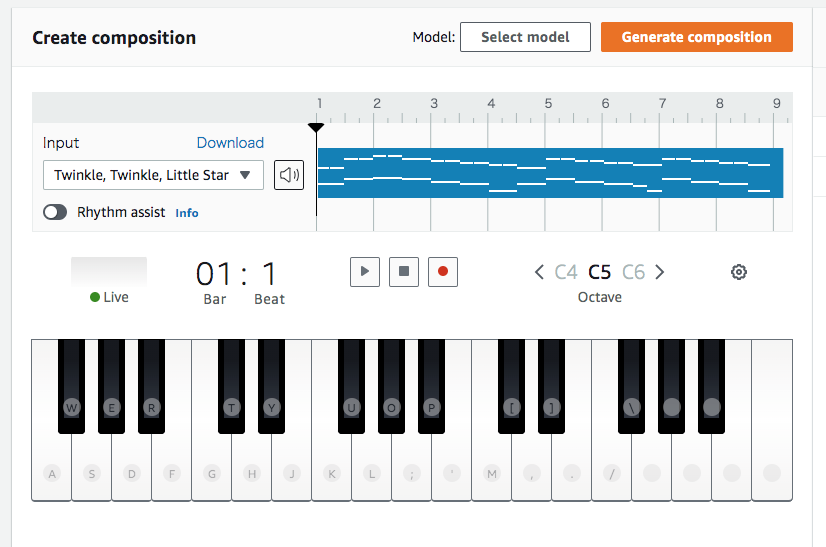

- 2020/04/07、緊急事態宣言が発令したこともあり、どこの企業もテレワークや在宅勤務

- AWSの「Workspaces」で環境をサクッとバリッと作成

- ちゃんとCloudTrailで監査ログ見れることを確認

対象読者

- テレワーク・在宅勤務を推奨している会社の情報システム部などの人

- テレワークするための論理武装したい人

- Workspaces好きで推進したい人

- CloudTrail好きな人

事の発端

ずっと前々から騒がれていたことですが、2020/04/07にとうとう緊急事態宣言が発令しました。これに伴い、どこの企業もテレワークや在宅勤務が発動しています。

筆者の周りでも強烈な動きが巻き起こっており、一斉に環境構築がなされています。Workspacesでやっちゃえば?

筆者はクラウドサービスのなかでAWSに最も慣れており、AWSが最も好きです。そう、AWSにはリモート環境が用意されています。それが「Amazon Workspaces」です。Amazon Workspacesを使うと、Windows または Linux のデスクトップが数分でセットアップできちゃいます。加えて、追加コストを払えばOfficeソフトをつけたWindowsもセットアップできます。

他のソリューションでもいいのですが、かんたんにスケールして多くの企業で使われているOfficeを使わなきゃいけないという要件は意外と辛いのですが、これなら解決できそうです。

ちゃんとログとれるよね?

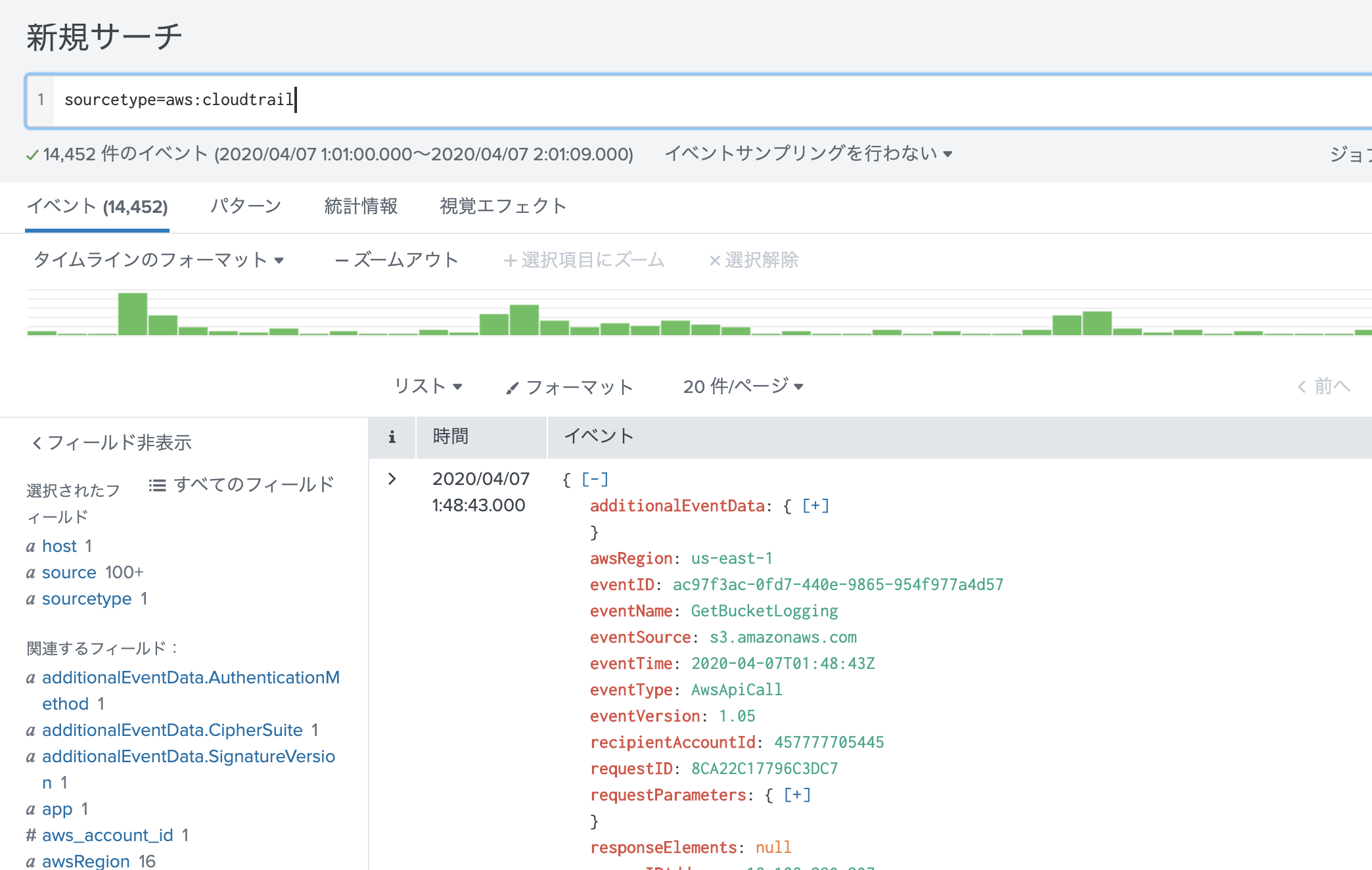

ここからが本題です。使うはいいけど、誰が使ったか情報システムとかに関わる人は気になりますよね。上から、本当に大丈夫とか言われて、ログもとってるんで大丈夫って言えたら楽ですよね。

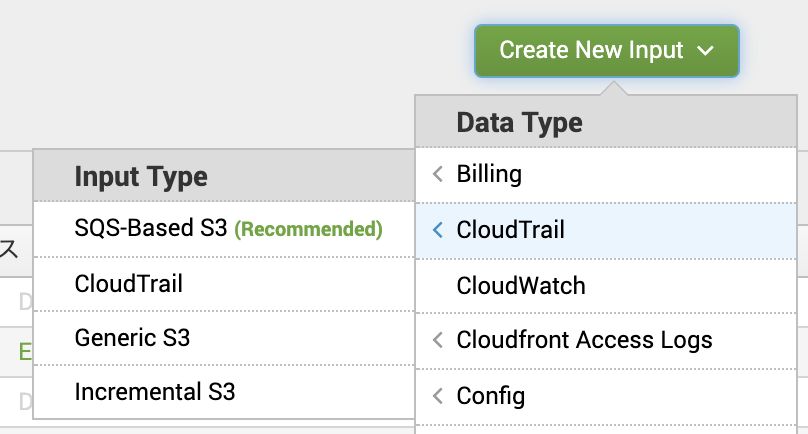

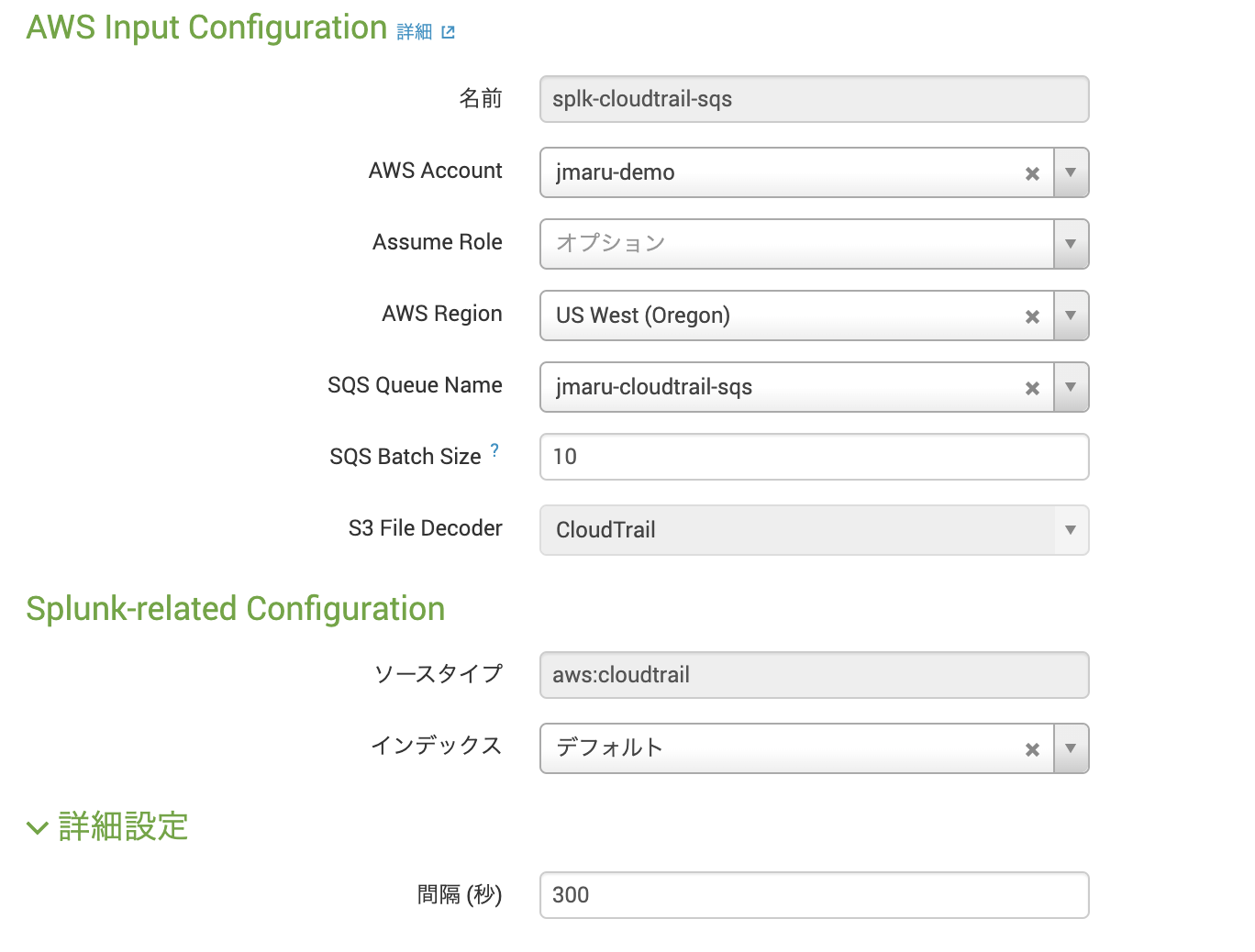

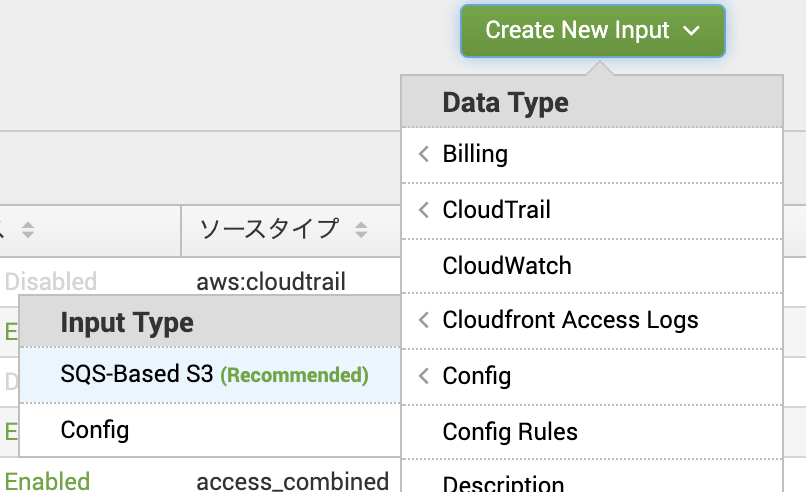

となったのでちゃんと確認しとこうとなりました。AWSでサービスを利用したログを確認となったら「AWS CloudTrail」です。

こちらを見ていただいたら分かる通り、CloudTrailの情報を確認する経路はたくさんあります。サポートされるサービス種類は下記のとおりです。

よし。Workspaces入ってるから問題ない。

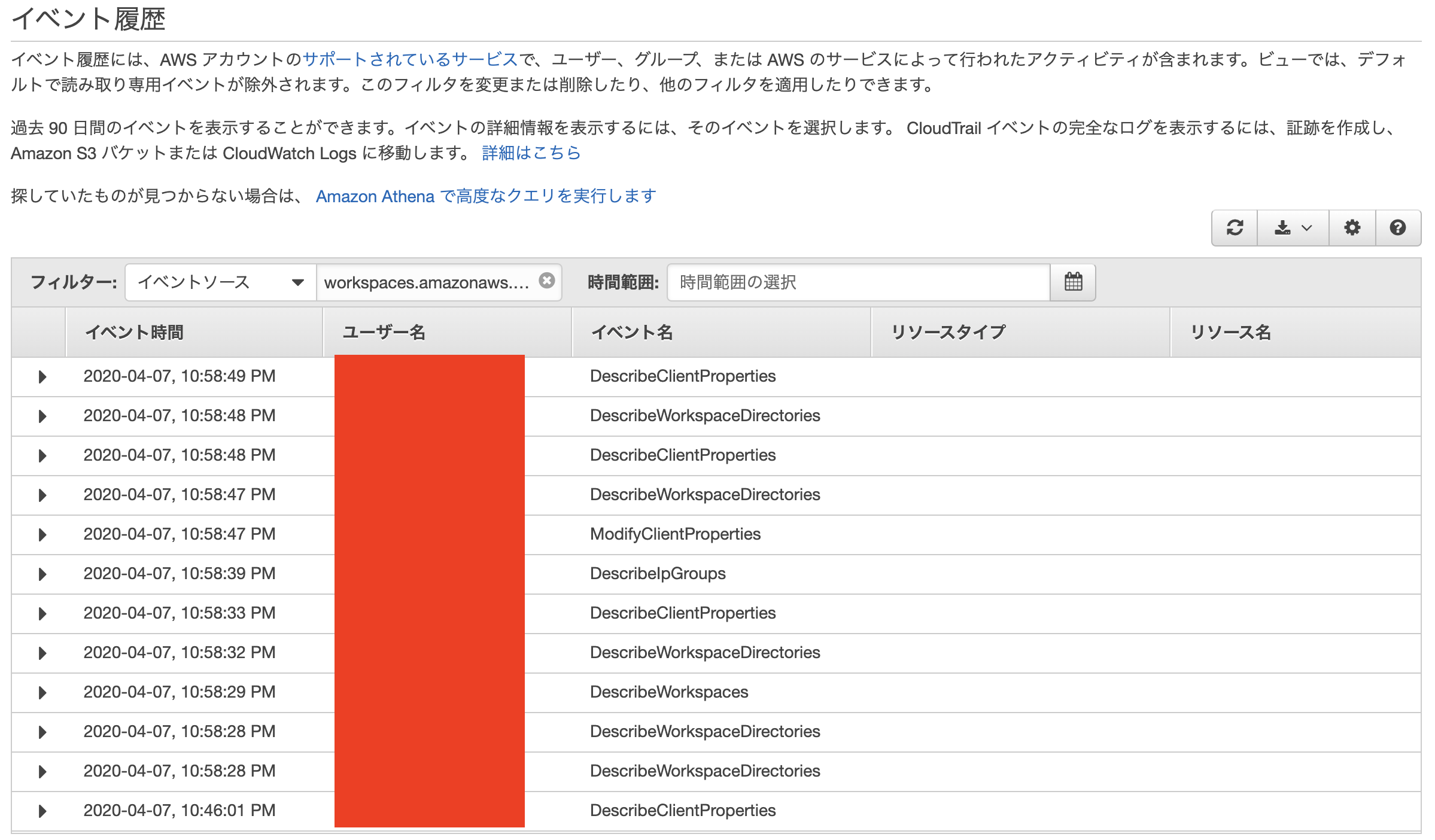

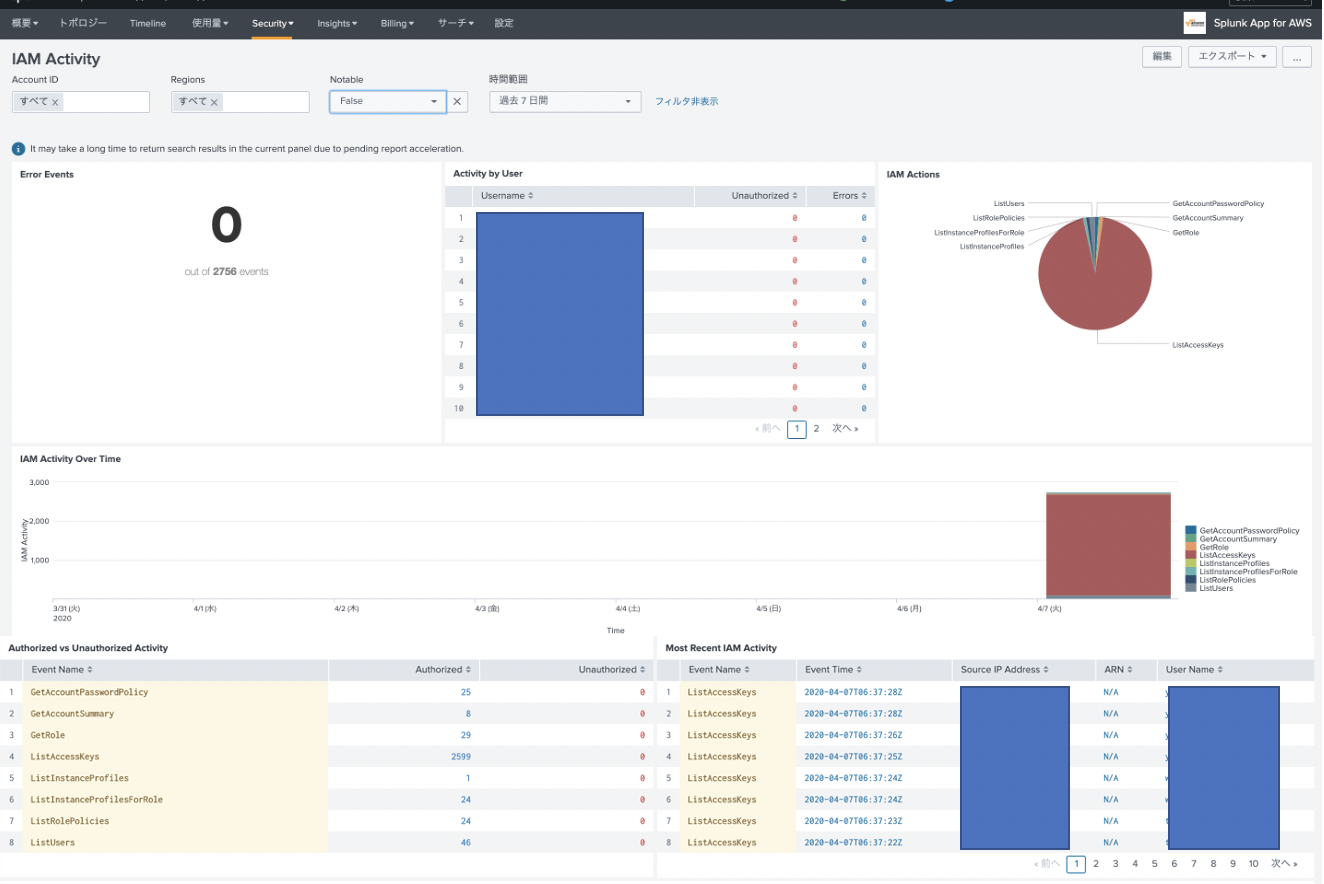

CloudTrail dashboardから確認

ログ取れていることみたいだけなのでダッシュボードから確認します。なお、CloudTrailで気をつけるべきはログ転送までに15分程度かかることです。よくある質問にも記載があります。WorkSpacesにアクセスして、ダッシュボードから確認してみましょう。

問題なく取れてますね。よかったよかった(なんか時間が少し古いような・・・)。

ダッシュボードにログが出てこないときは・・・

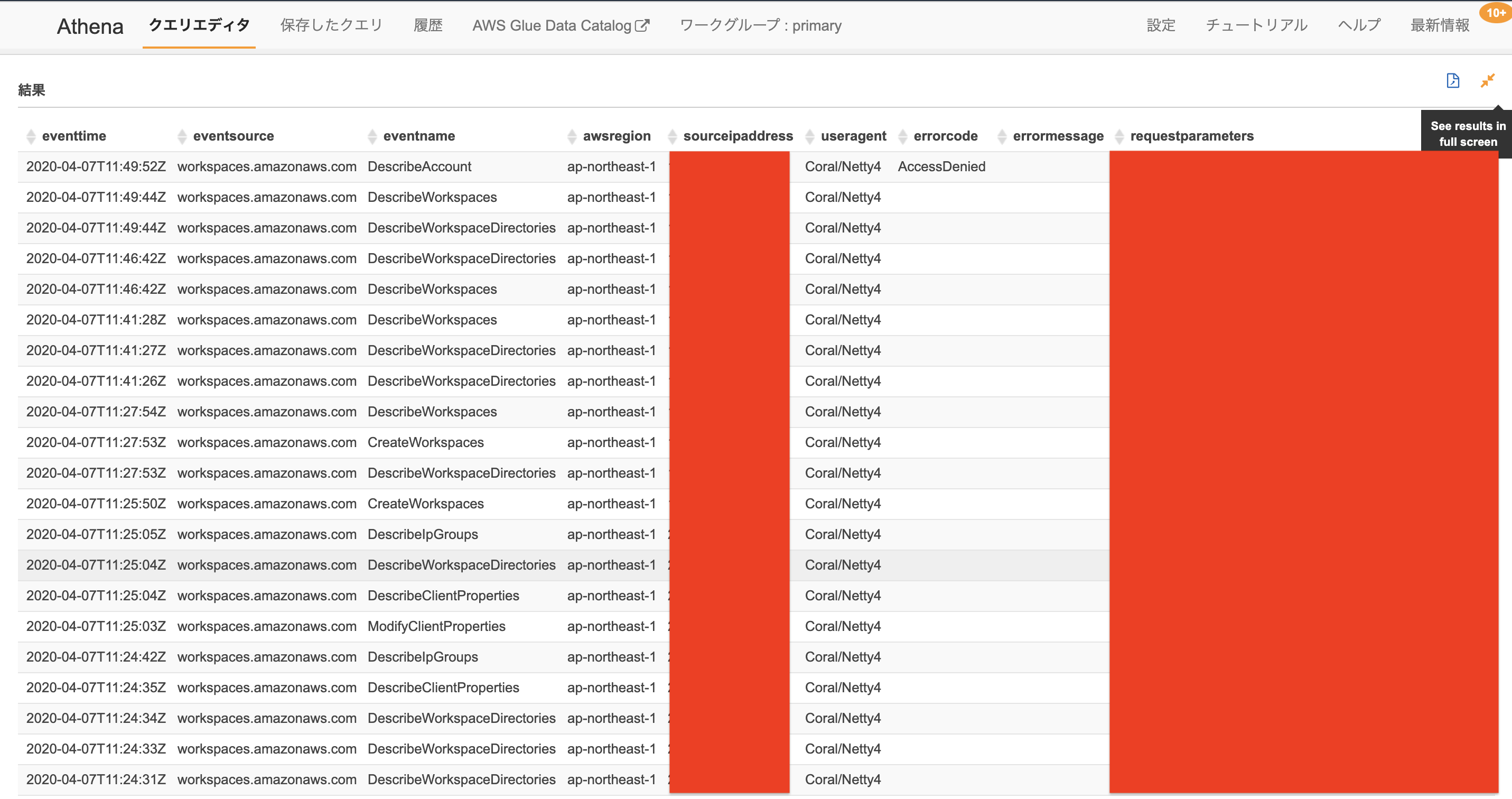

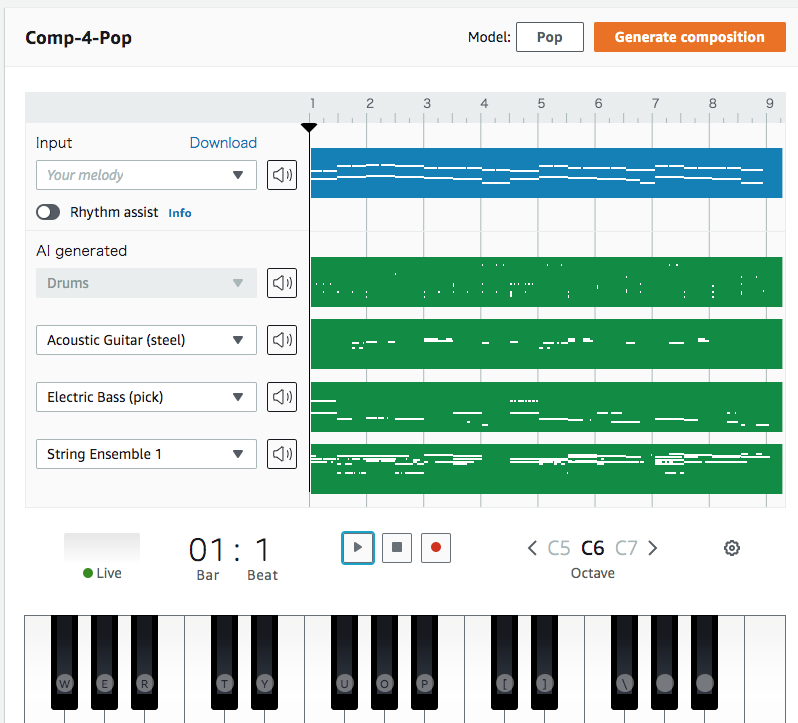

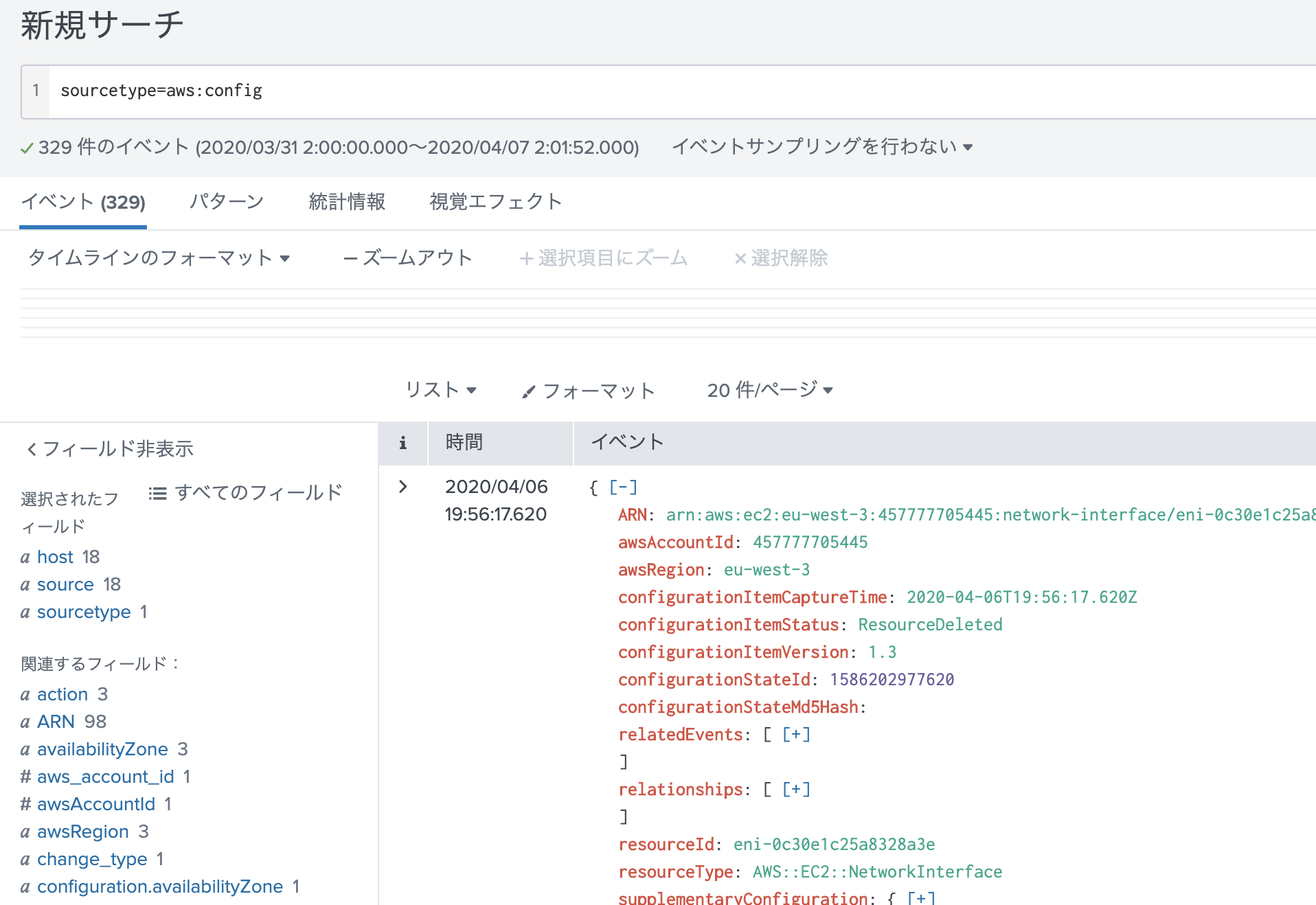

当方最初ダッシュボードから検索しても何もHITしませんでした。もちろん15分以上時間を撮ってアクセスしています。あれーー?ってなっててS3にストアされているログをあさりにいきました。S3から復元するのはめんどくさいので、Amazon Athena(S3に対してSQL文を発行してインタラクティブにログ検索できるサービス)を使いました。CloudTrailログをAthenaで検索することは割と簡単です。CloudTrailの画面上にある「探していたものが見つからない場合は、 Amazon Athena で高度なクエリを実行します」の手順に沿ってS3のバケットの設定などをしていくと利用できます。

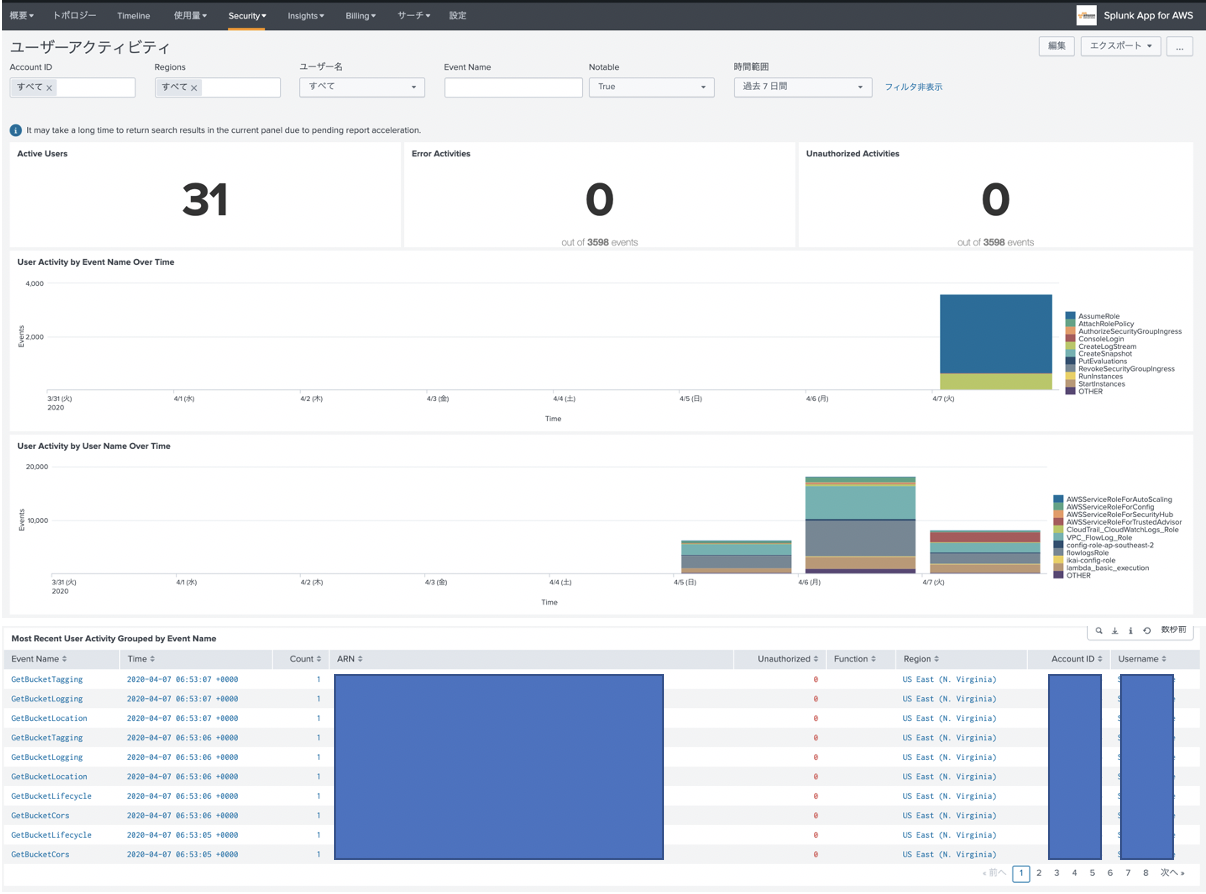

Athenaを使うとごそっとログが抽出でき、最近の時間のものまで取得ができました。極力リアルタイムにすべてのログを抜き取るときはCloudTrailダッシュボードではなく、Athenaを利用して、Workspacesのログを取得したほうがよいことがわかりました。

まとめ

- こんな状況なので、できる限りテレワークや在宅勤務をしましょう。

- Workspacesを使えば比較的カンタンにサクッとリモート環境構築できます。

- CloudTrailでWorkspacesのログを見るときはダッシュボード、見つからなくて急ぎのときはAthenaを使いましょう。

- 投稿日:2020-04-07T21:24:37+09:00

サーバーレスライブラリbrefを使い、素のPHPでHello world

ちょっと素のPHPが欲しいときがあったら、以下のようにさくっとデプロイできます。

$ serverless # プロジェクト作成 https://github.com/umihico/bref-demo/commit/0269a62 Serverless: No project detected. Do you want to create a new one? Yes Serverless: What do you want to make? AWS Node.js Serverless: What do you want to call this project? bref-demo Project successfully created in 'bref-demo' folder. You can monitor, troubleshoot, and test your new service with a free Serverless account. Serverless: Would you like to enable this? No You can run the “serverless” command again if you change your mind later. $ cd bref-demo $ composer require bref/bref # brefインストール https://github.com/umihico/bref-demo/commit/2143b4e本命のPHPファイルを追加し、serverless.ymlを設定します。0e8c61d

index.php+ <?php + + require __DIR__ . '/vendor/autoload.php'; + + lambda(function ($event) { + return [ + 'headers' => [ + 'Content-Type' => 'text/html' + ], + 'statusCode' => 200, + 'body' => '<html><!doctype html><head></head><body><h1>Go Serverless v1.0! Your function executed successfully!</h1></html>', + ]; + });serverless.ymlprovider: name: aws - runtime: nodejs12.x + runtime: provided + +plugins: + - ./vendor/bref/bref functions: hello: - handler: handler.hello -# The following are a few example events you can configure -# NOTE: Please make sure to change your handler code to work with those events -# Check the event documentation for details -# events: -# - http: -# path: users/create -# method: get + handler: index.php + timeout: 28 + layers: + - ${bref:layer.php-73-fpm} + events: + - http: 'ANY /' + - http: 'ANY /{proxy+}' # - websocket: $connect

serverless deployで発行されたURLにアクセスしてみると、

ちゃんとHTMLが描写されていますね。jsonを返したい場合はこうです。66df3alambda(function ($event) { - return [ - 'headers' => [ - 'Content-Type' => 'text/html' - ], - 'statusCode' => 200, - 'body' => '<html><!doctype html><head></head><body><h1>Go Serverless v1.0! Your function executed successfully!</h1></html>', - ]; + return [ + 'headers' => [ + 'Content-Type' => "application/json", + ], + 'statusCode' => 200, + 'body' => json_encode(['json_key' => 'json_value']), + ]; });参考

- 投稿日:2020-04-07T20:55:34+09:00

Rails5.2以降でAWSへデプロイ完全版+DBはmysql+無料でSSL化+独自ドメイン取得(お名前.com)

はじめに

表題の通りですがAWSにて環境構築から独自ドメイン取得までを記載しております。

rails5.2以降でのデプロイが難航し環境構築から独自ドメイン取得まで一貫した記事が無く、人柱となりて共有できればと思い記事として残すことにしました。

rails5.2以降ではsecrets.ymlがcredentials.yml.encに変更になり、呼び出し方が異なるのでその部分が躓くかと存じます。また、ドメイン・SSL化はなかなか教材には無かったのでご参考になれば幸いです。不手際がございましたら、コメントにいただけると有り難いです。

できるだけコピペでいきたいですね。では参りましょう!前提条件

- githubにリポジトリが登録できている

- そのリポジトリに rails new したもの(rails5.2以降)が登録できている

- databaseはmysqlである

- AWSでアカウントが登録できている

- 寛大な心を持っている

流れ

- AWS内の環境構築

- unicornの導入

- nginxの導入

- capistranoの導入

- お名前.comでドメインを購入し、AWSと紐付け

- 無料SSL化(Let's Encrypt)

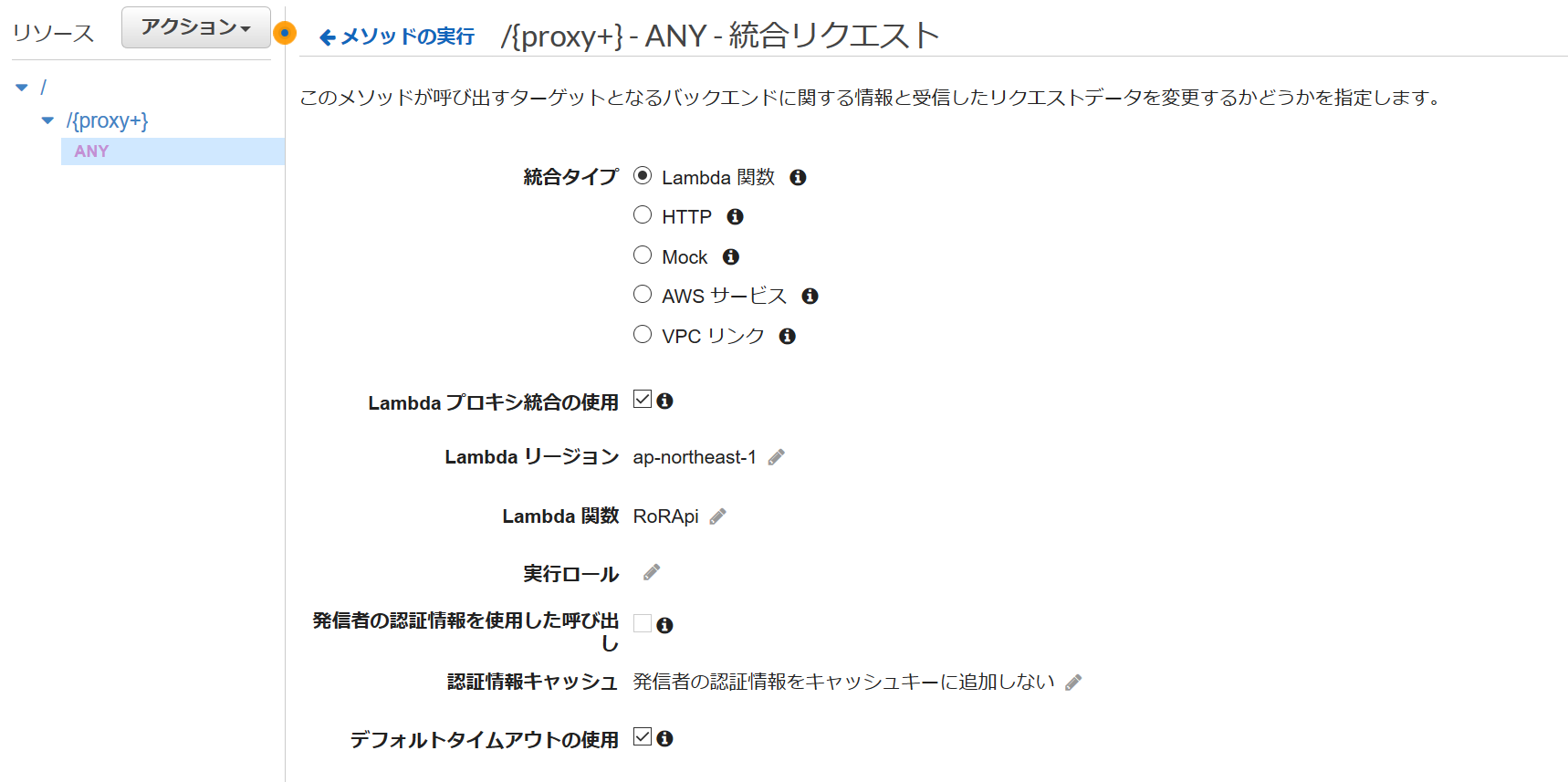

AWS内の環境構築

AWSのEC2というサービスを使って、全世界に作成したサイトを公開するサーバを作成します。いくつかの設定をし、作成したサーバにログインして操作できるようにします。EC2で作成したサーバは、結局はターミナルを介して遠隔操作できるパソコンです。慣れましょう!(投げやり感)

- AWSアカウントのリージョン設定

リージョンとは、AWSの物理的なサーバの場所を指定するものです。リージョンは世界各地に10箇所以上存在し、そのうちの一つは東京にあります。

まずは【こちら】からAWSアカウントにログインします。次に日本にお住まいの方は「東京」を選択してください。

- EC2インスタンスの作成

「仮想マシン」のことをAWSでは「EC2インスタンス」と呼んでいます。

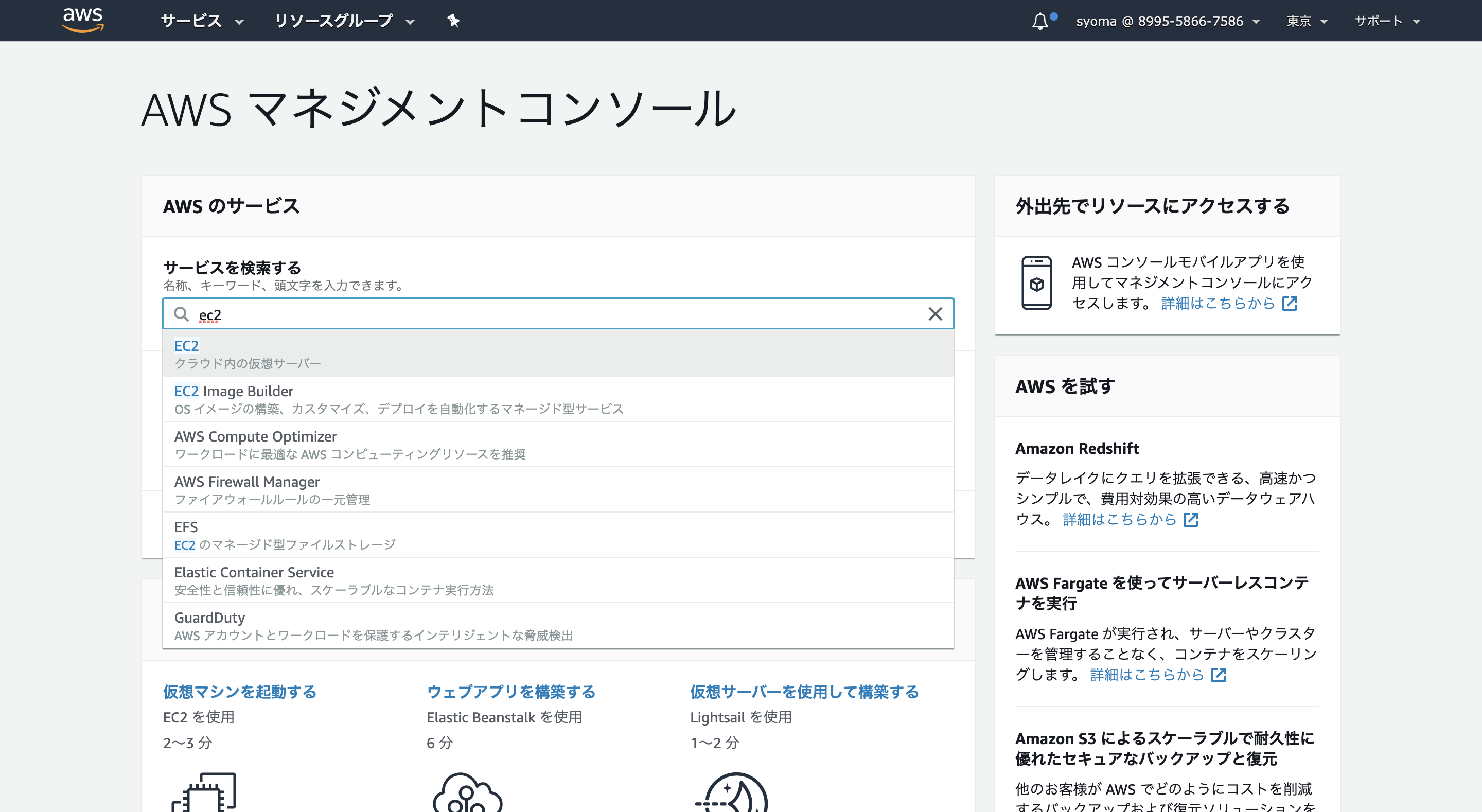

「EC2」を選択しましょう。

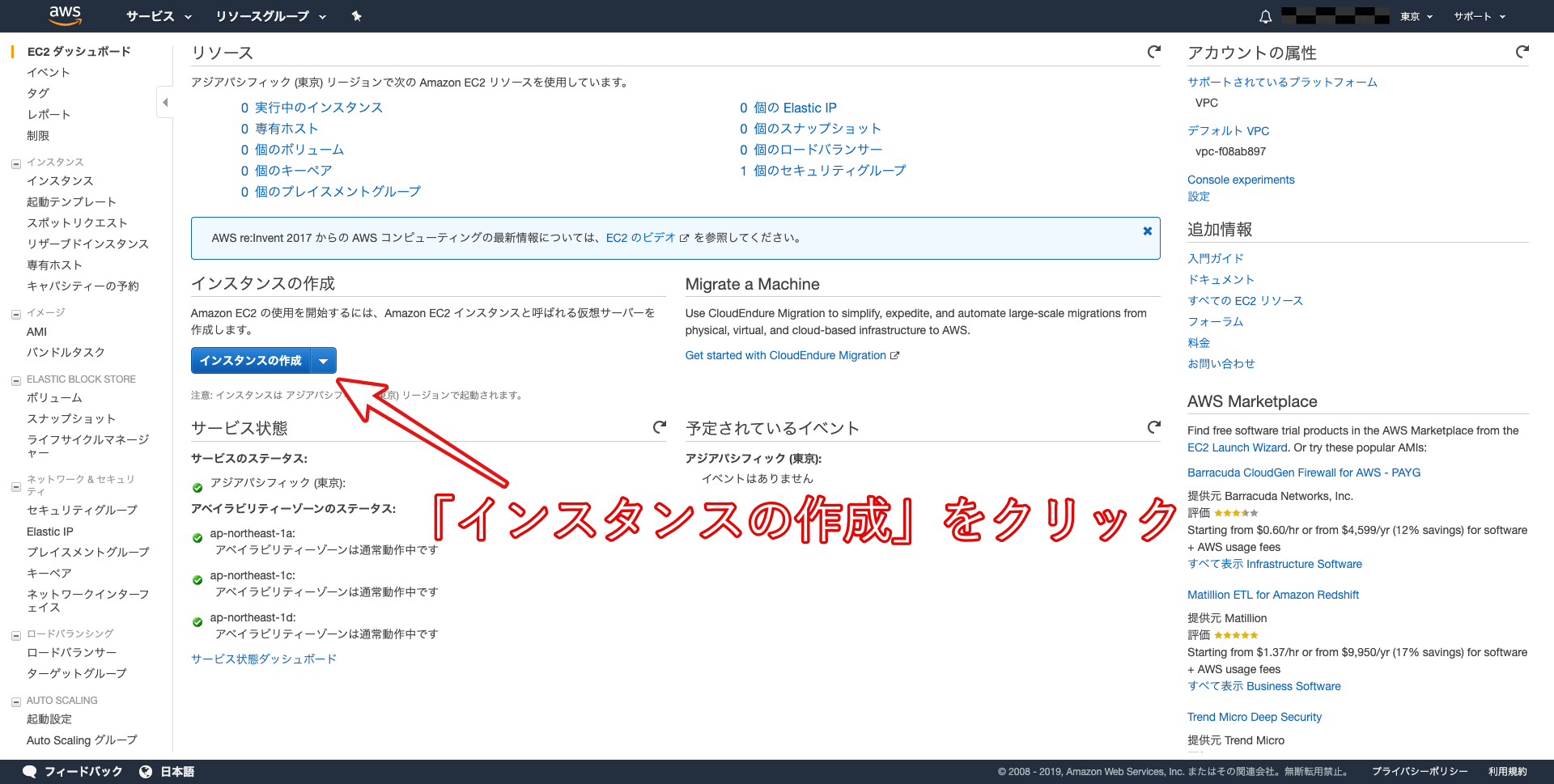

以下の画像のように「インスタンスの作成」をクリックしましょう。

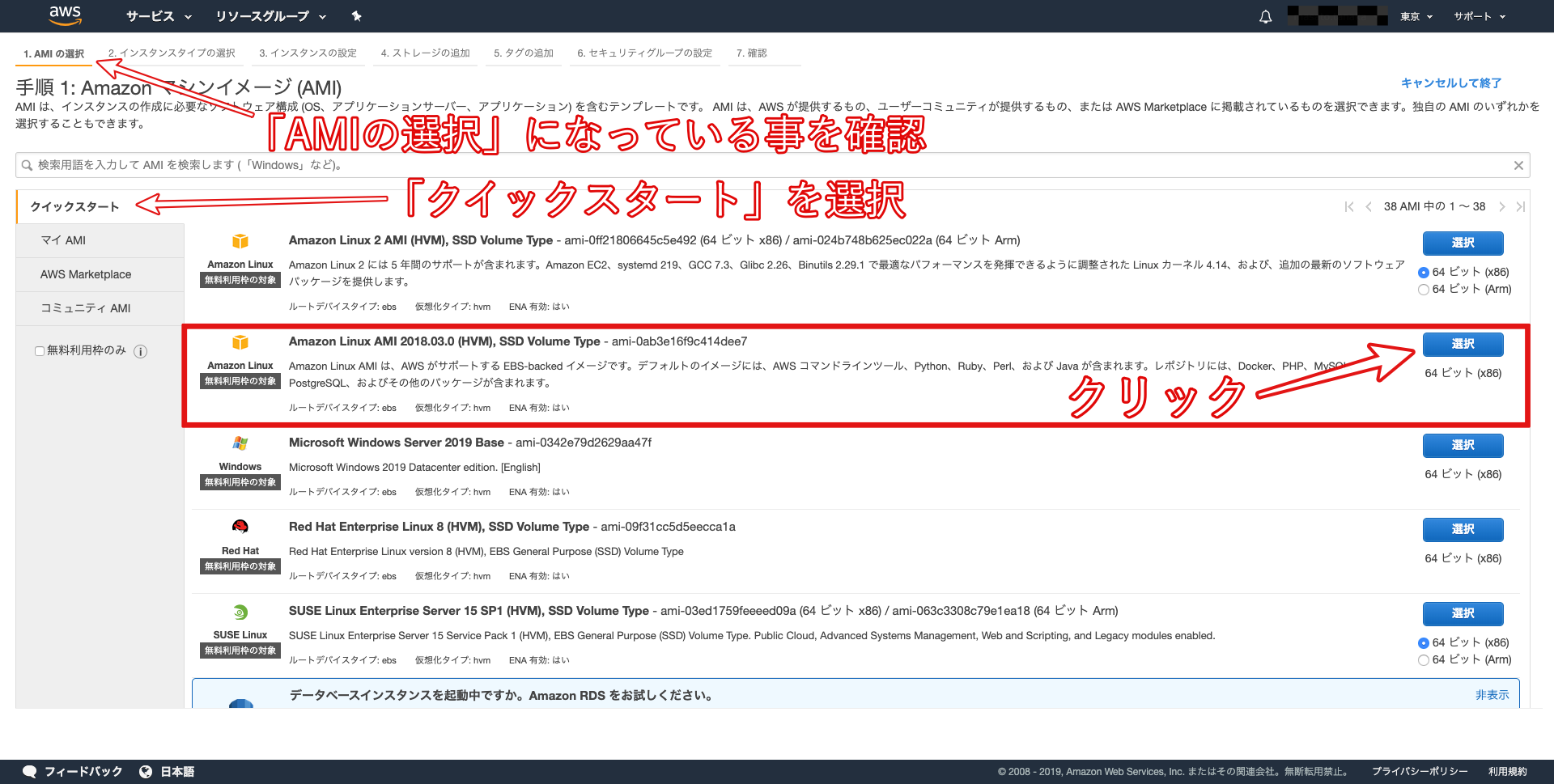

以下の画像のように「 Amazon Linux AMI 」を選択してください。

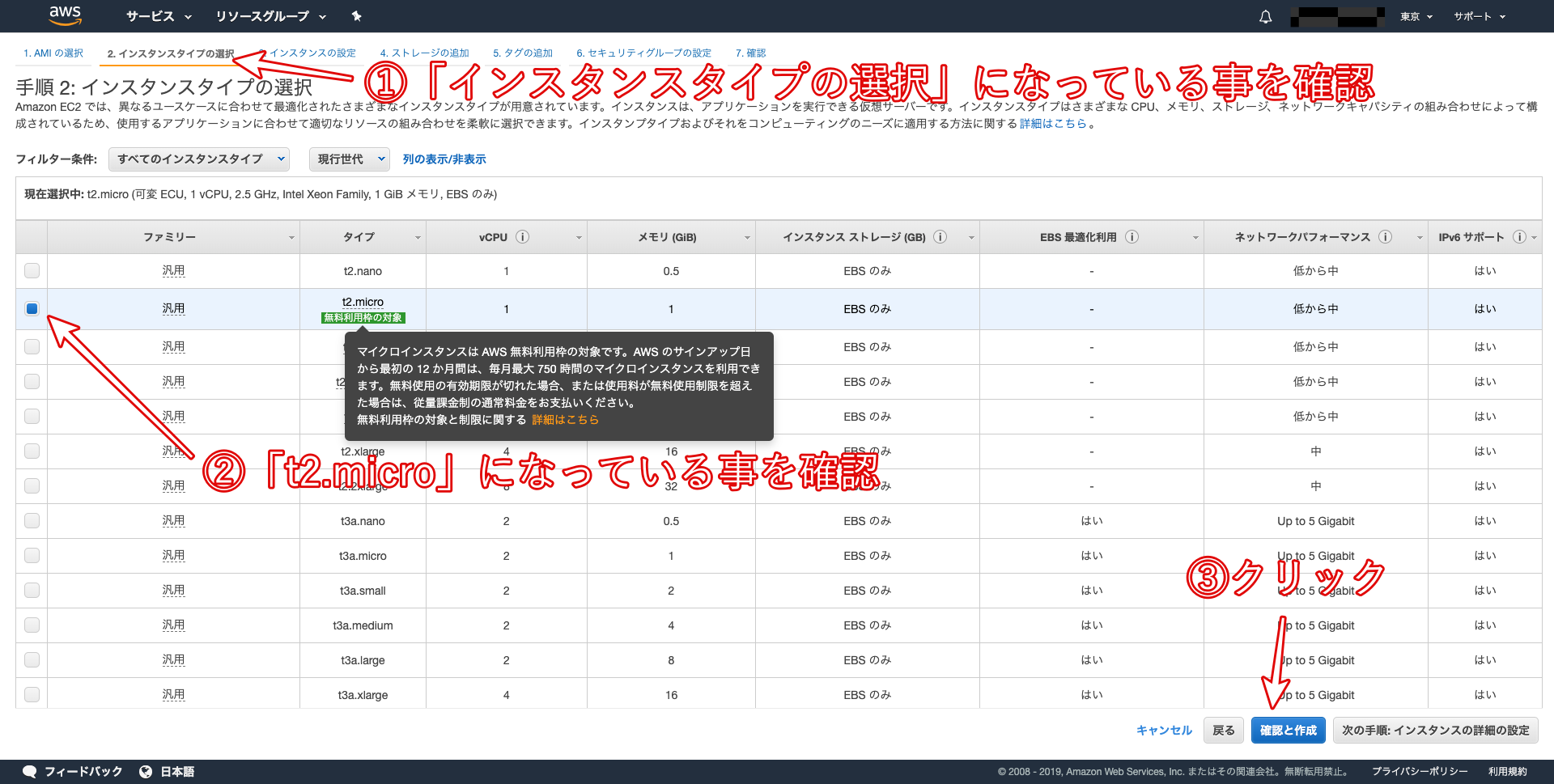

EC2インスタンスのタイプを選択します。EC2ではさまざまなインスタンスタイプが用意されており、CPUやメモリなどのスペックを柔軟に指定することができます。

今回は、無料枠で利用できる「t2.micro」を選択しましょう。

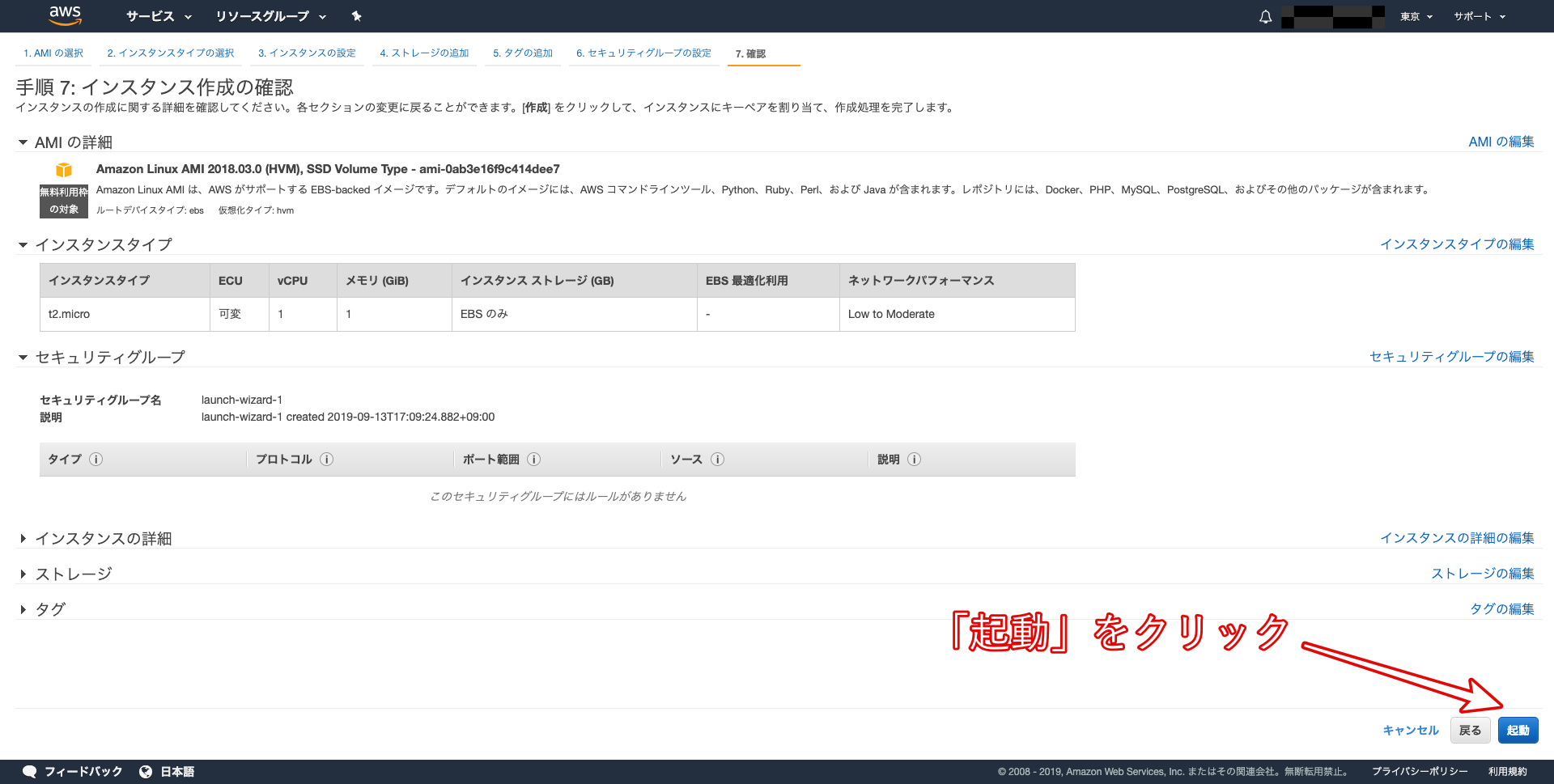

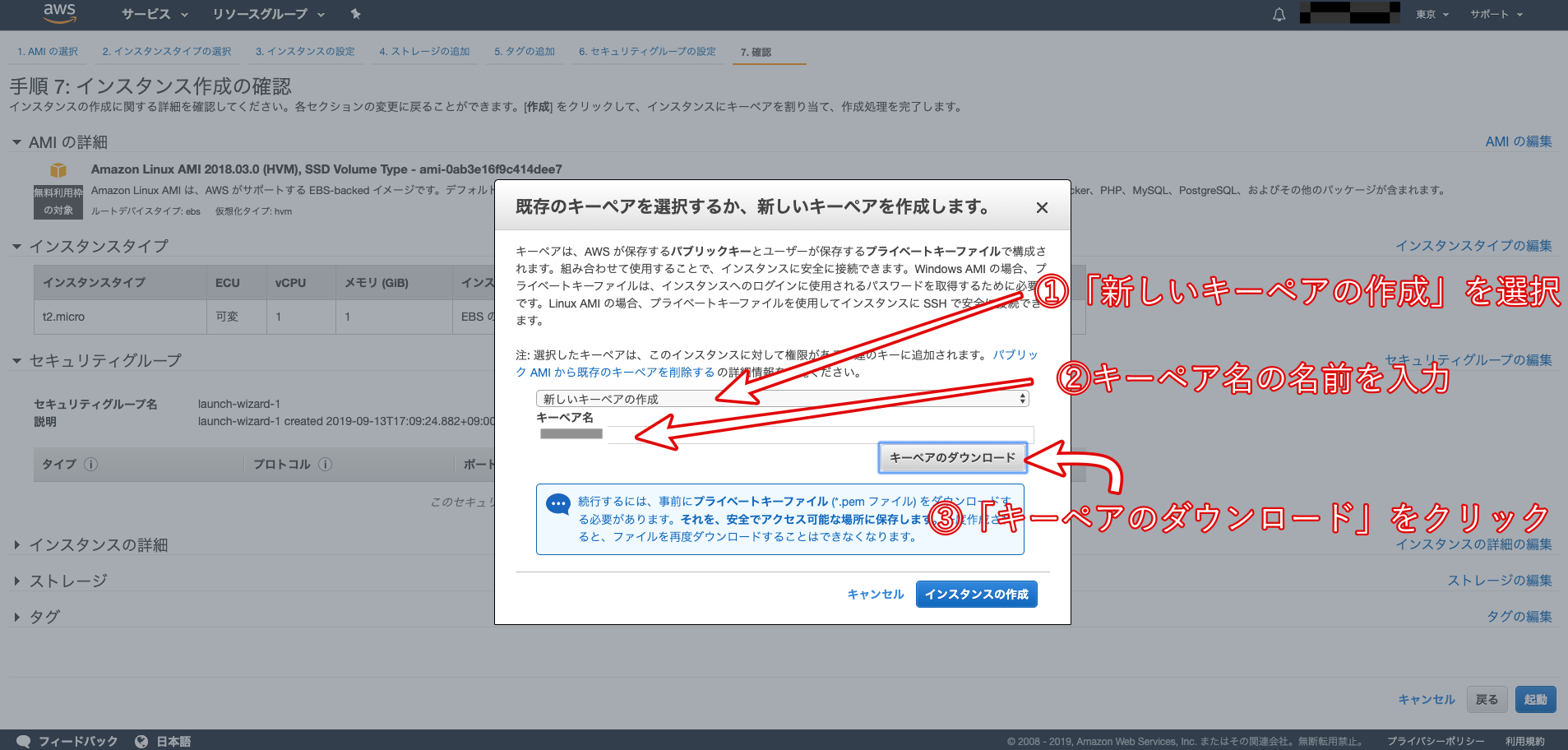

「キーペア」をダウンロードすることが出来ます。こちらはインスタンスにSSHでログインする際に必要となる「秘密鍵」です。これがないとEC2インスタンスにログインできないので、必ずダウンロードしてパソコンに保存しておきましょう。

※スペースを含まない名前の秘密鍵を作成するようにしましょう!キーペアのダウンロードが完了すると、クリック出来ない状態になっていた「インスタンスの作成」が、クリックできるように変更されます。そちらをクリックして、EC2インスタンスを作成しましょう。

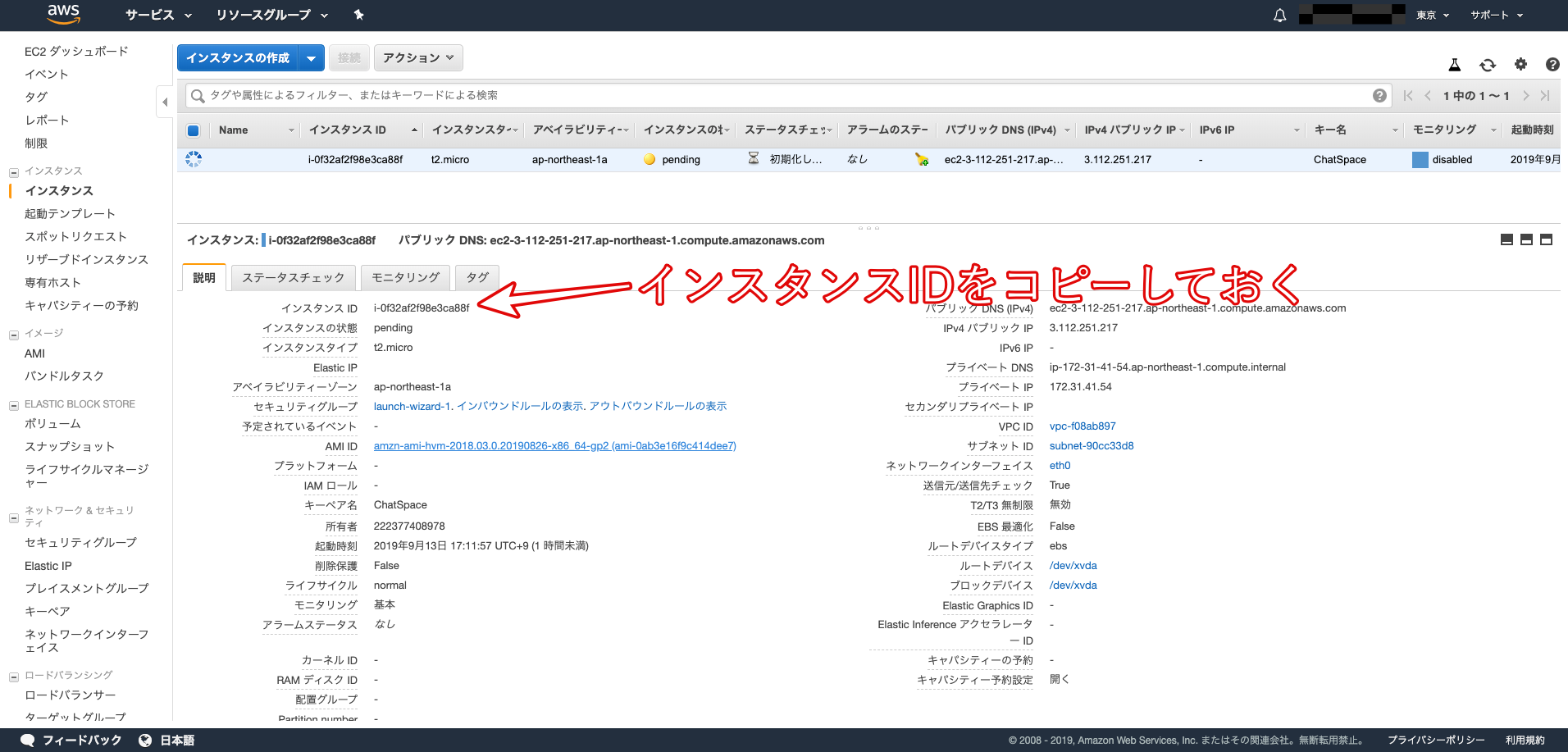

その後、インスタンス一覧画面に戻り、作成した「インスタンスID」をコピーしてメモしておきましょう。

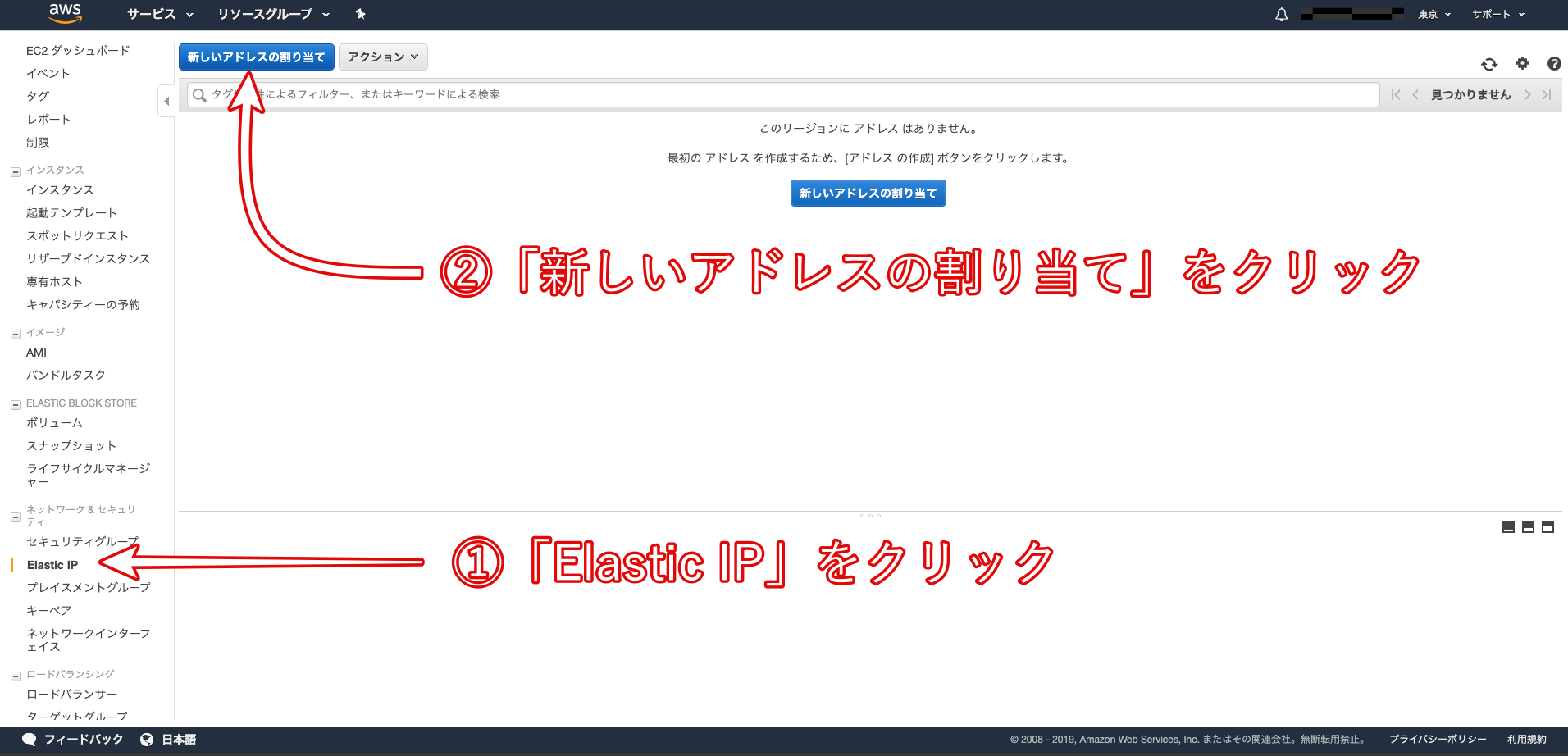

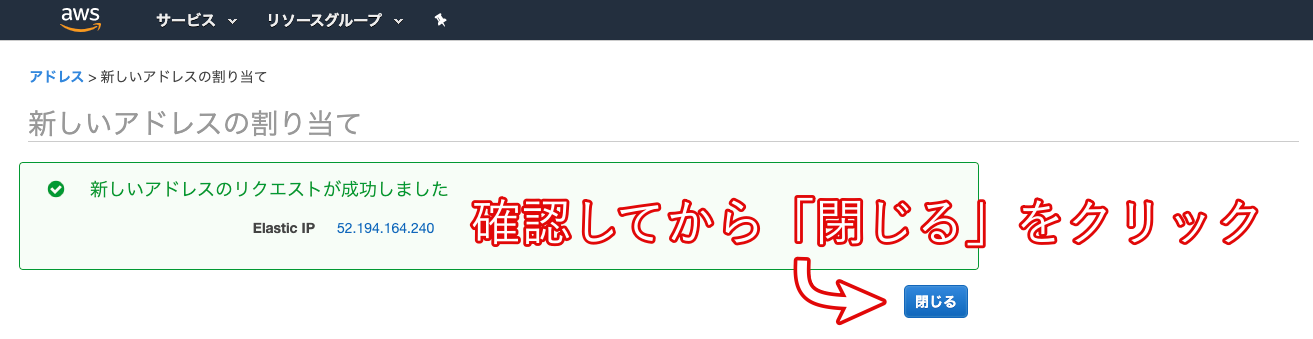

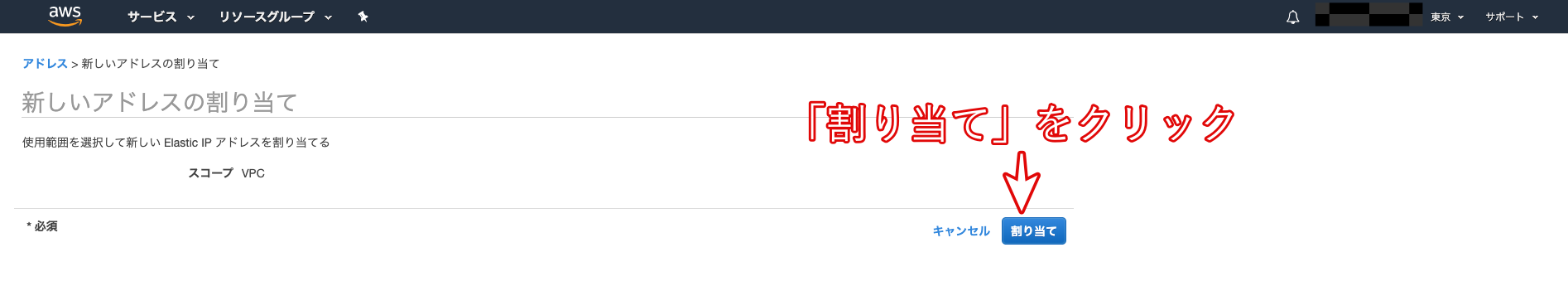

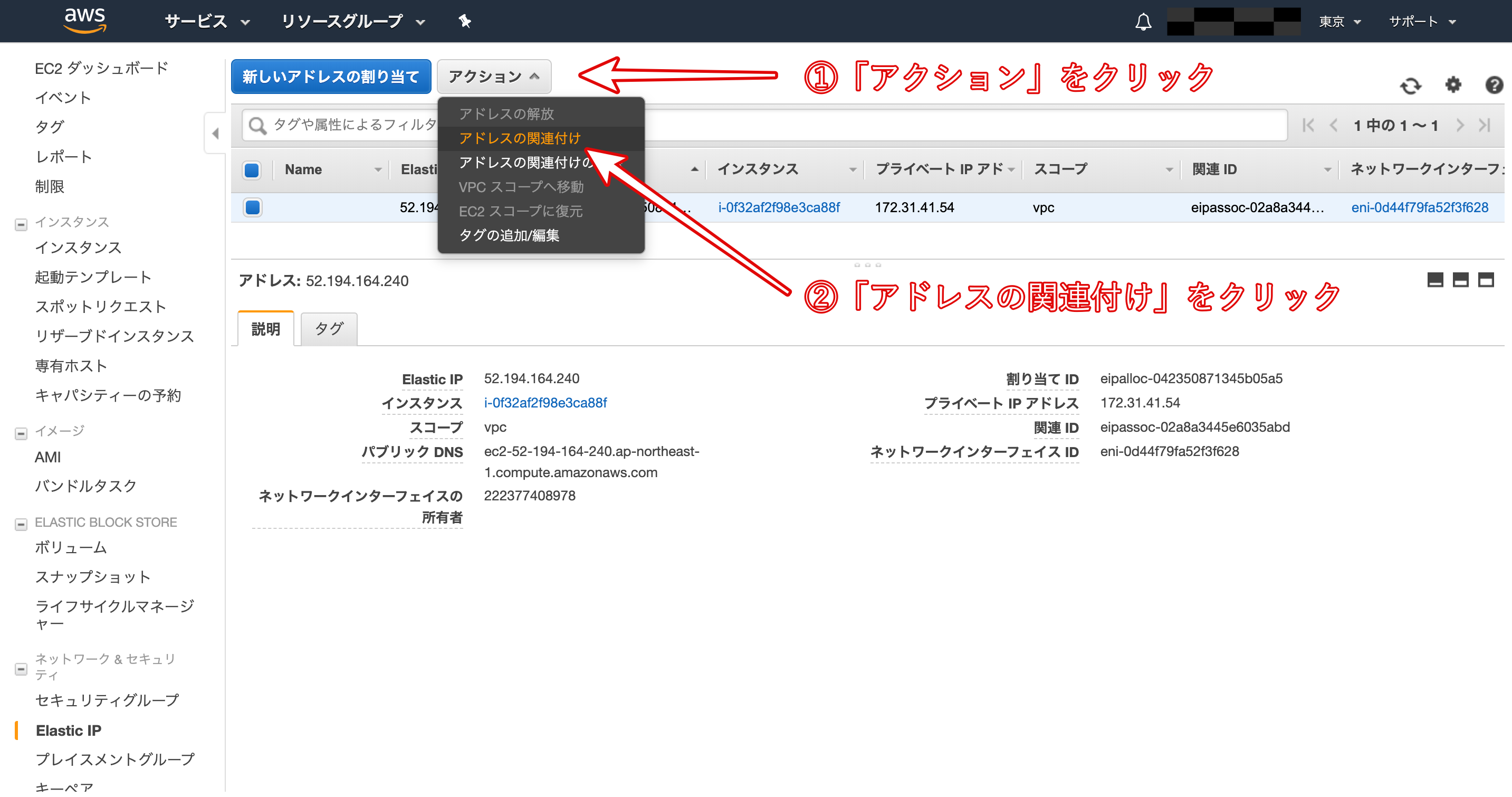

- Elastic IPの作成と紐付け

Elastic IPとは、AWSから割り振られた固定のパブリックIPアドレスのことです。

Elastic IPを取得するために、以下の画像の手順に従って作業をしていきましょう。

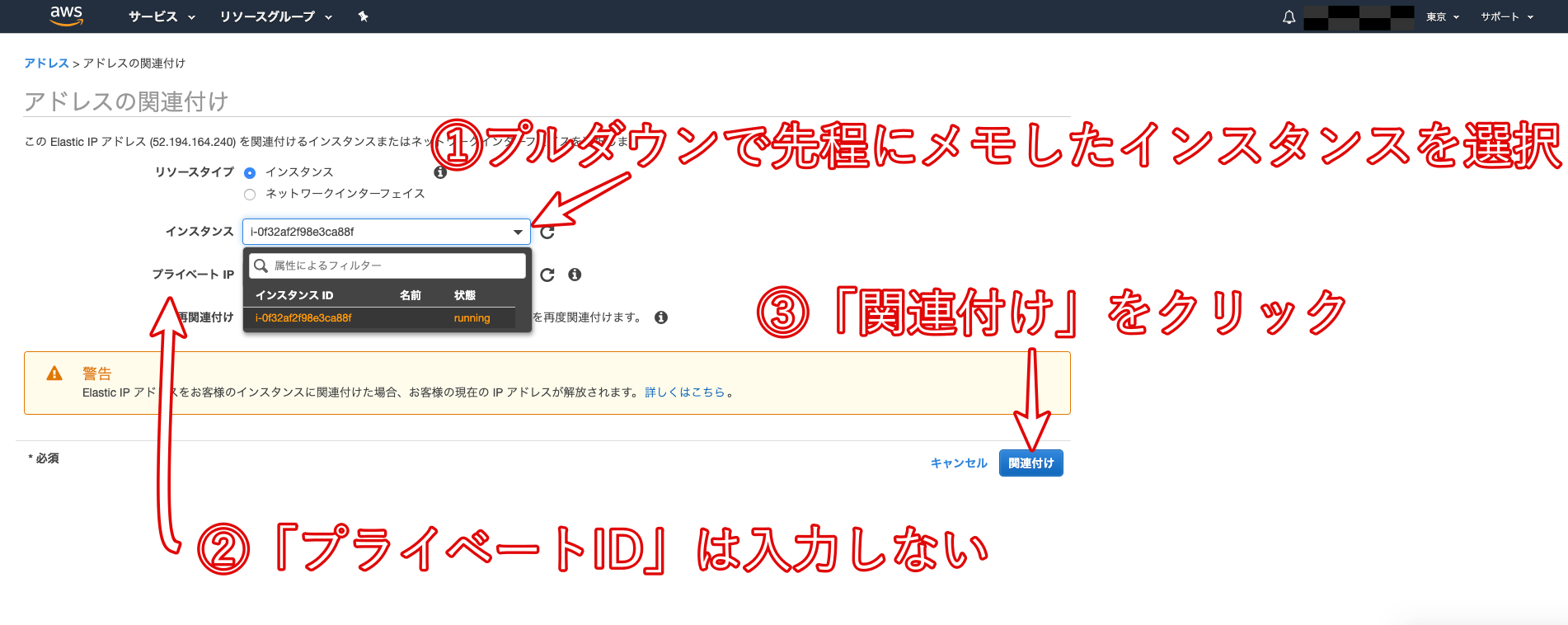

上の画像のようにインスタンスを選択すると、その下にあるプライベートIPアドレスが自動で選択されます。

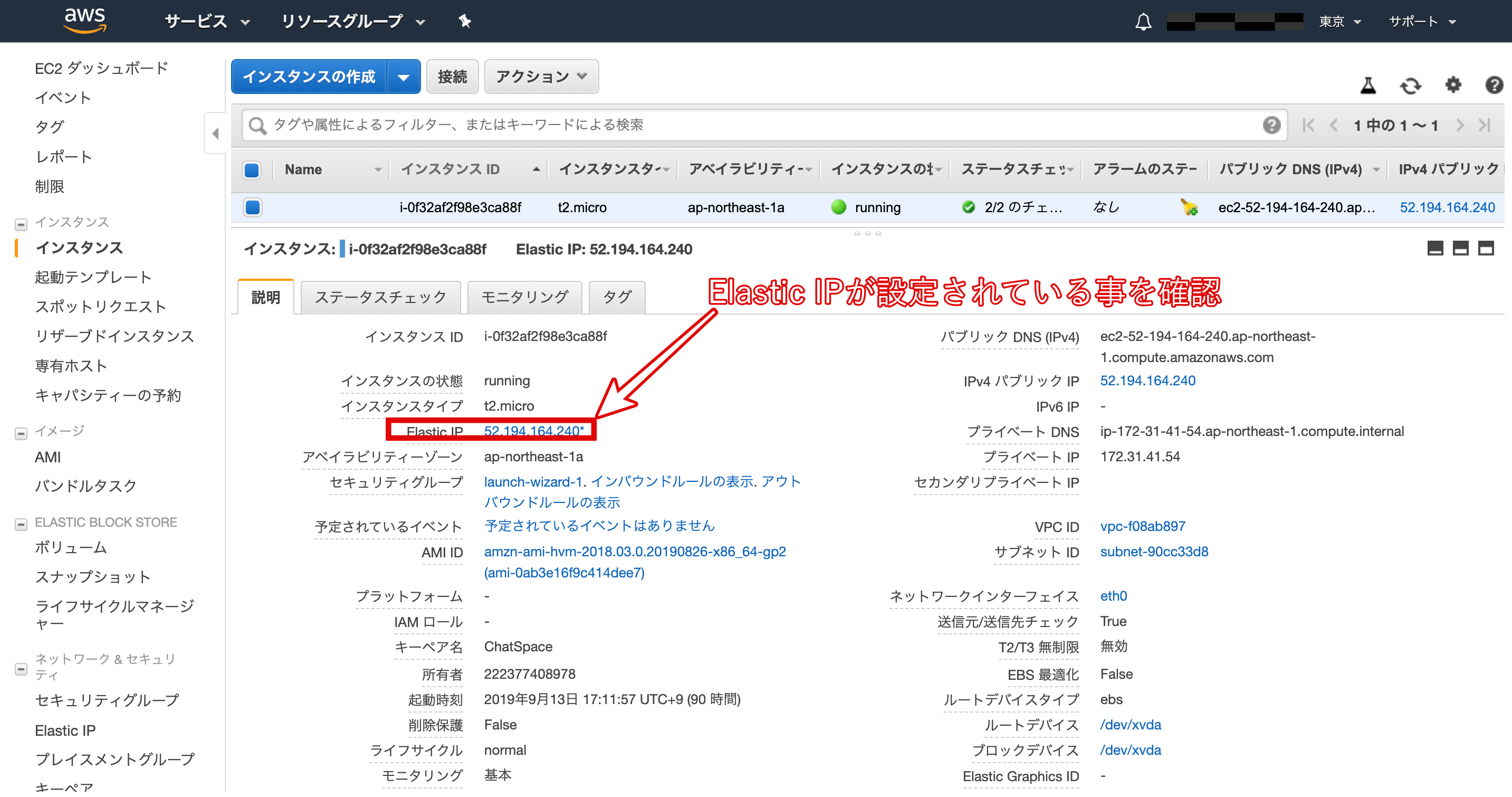

再びインスタンス一覧画面に戻り、作成したインスタンスの「パブリック IP」と「Elastic IP」が同じものに設定されていることを確認しましょう。

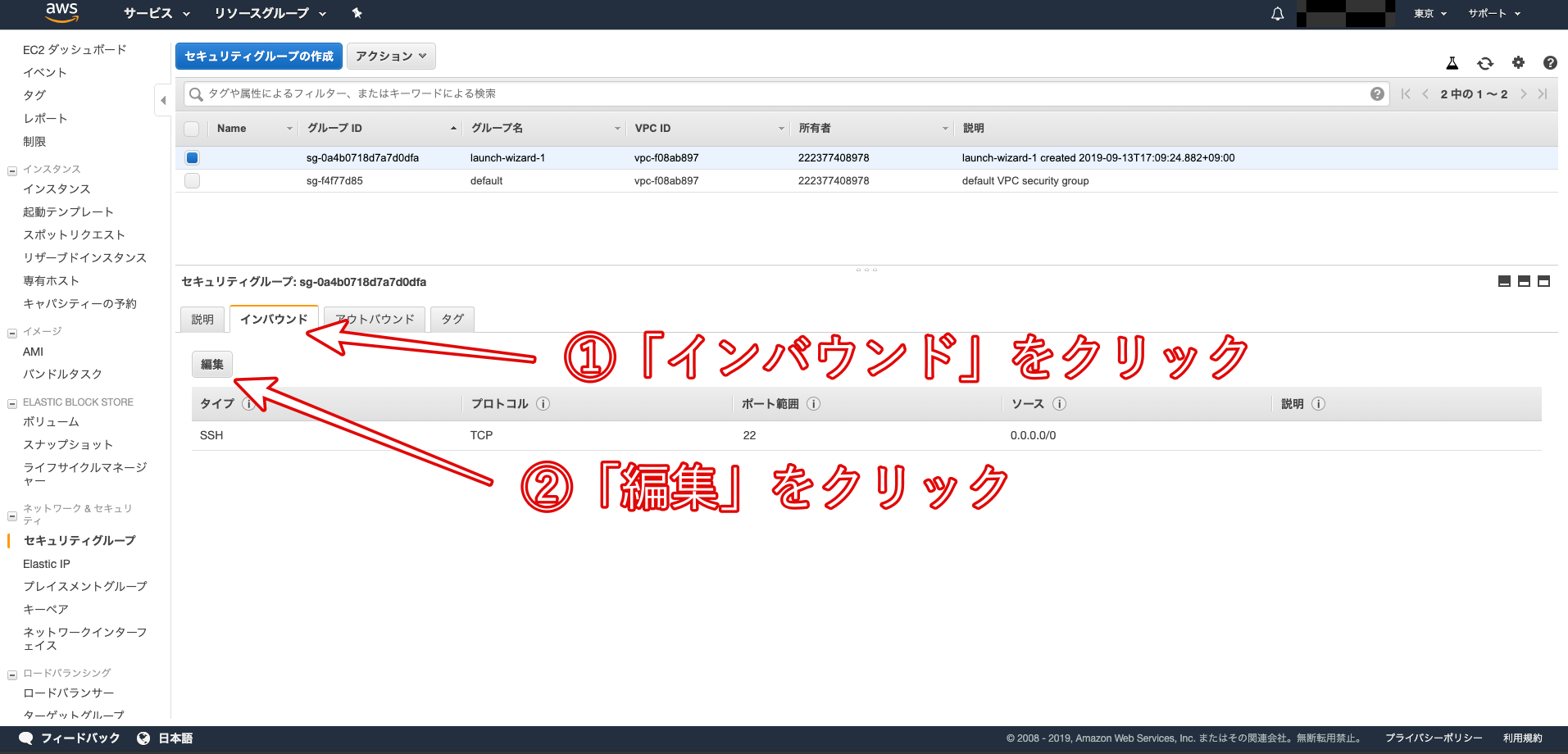

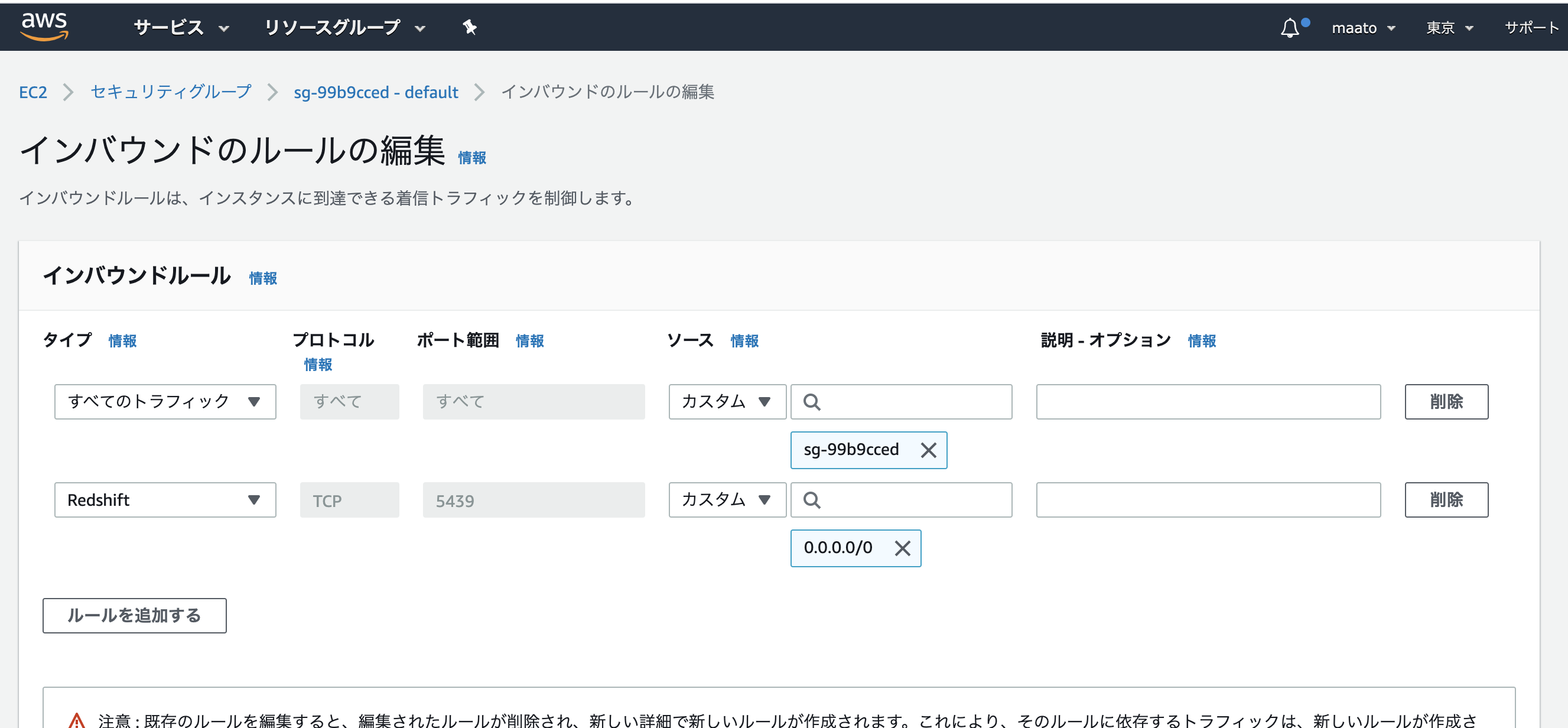

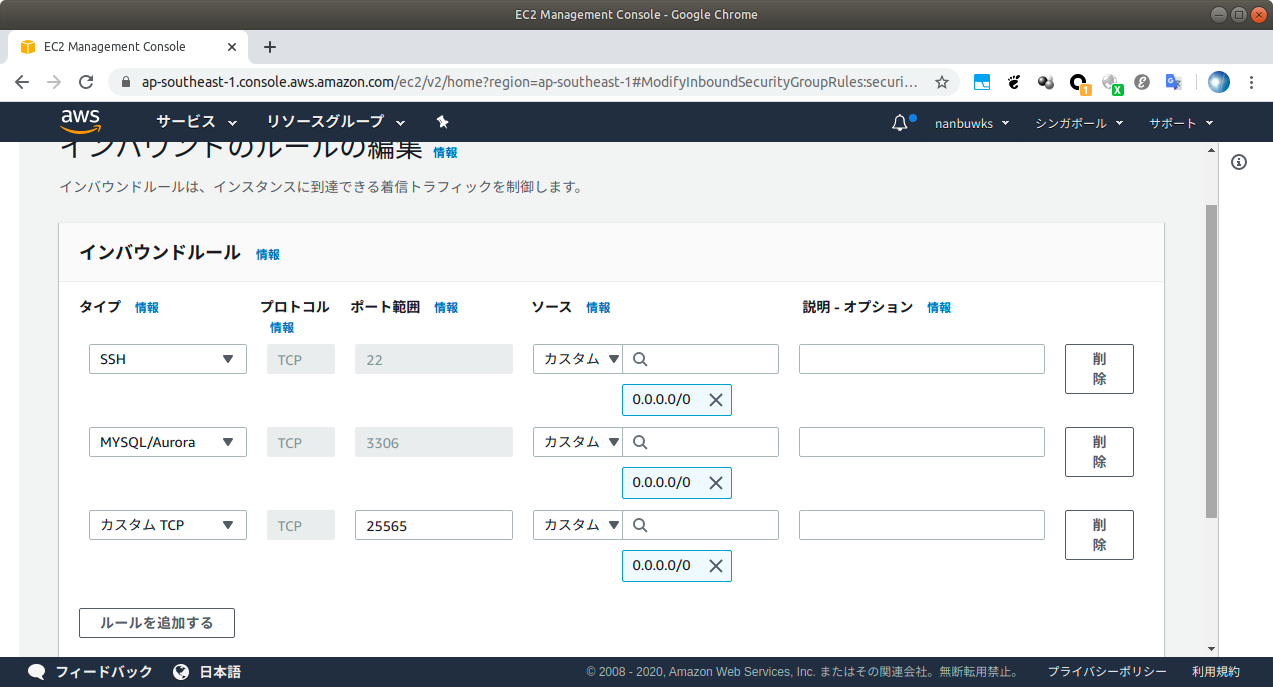

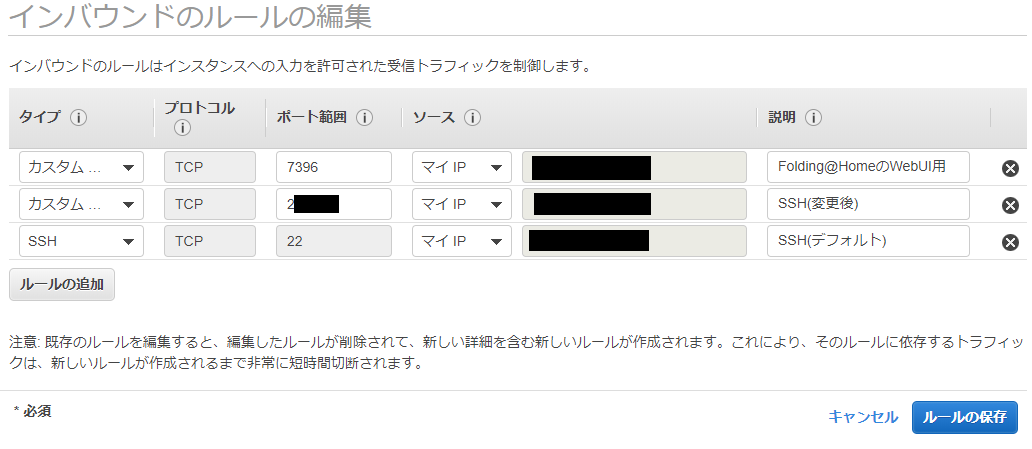

- ポート解放1

立ち上げたばかりのEC2インスタンスはSSHでアクセスすることはできますが、HTTPなどの他の接続は一切つながらないようになっています。そのため、WEBサーバとして利用するEC2インスタンスは事前にHTTPがつながるように「ポート」を開放する必要があります。

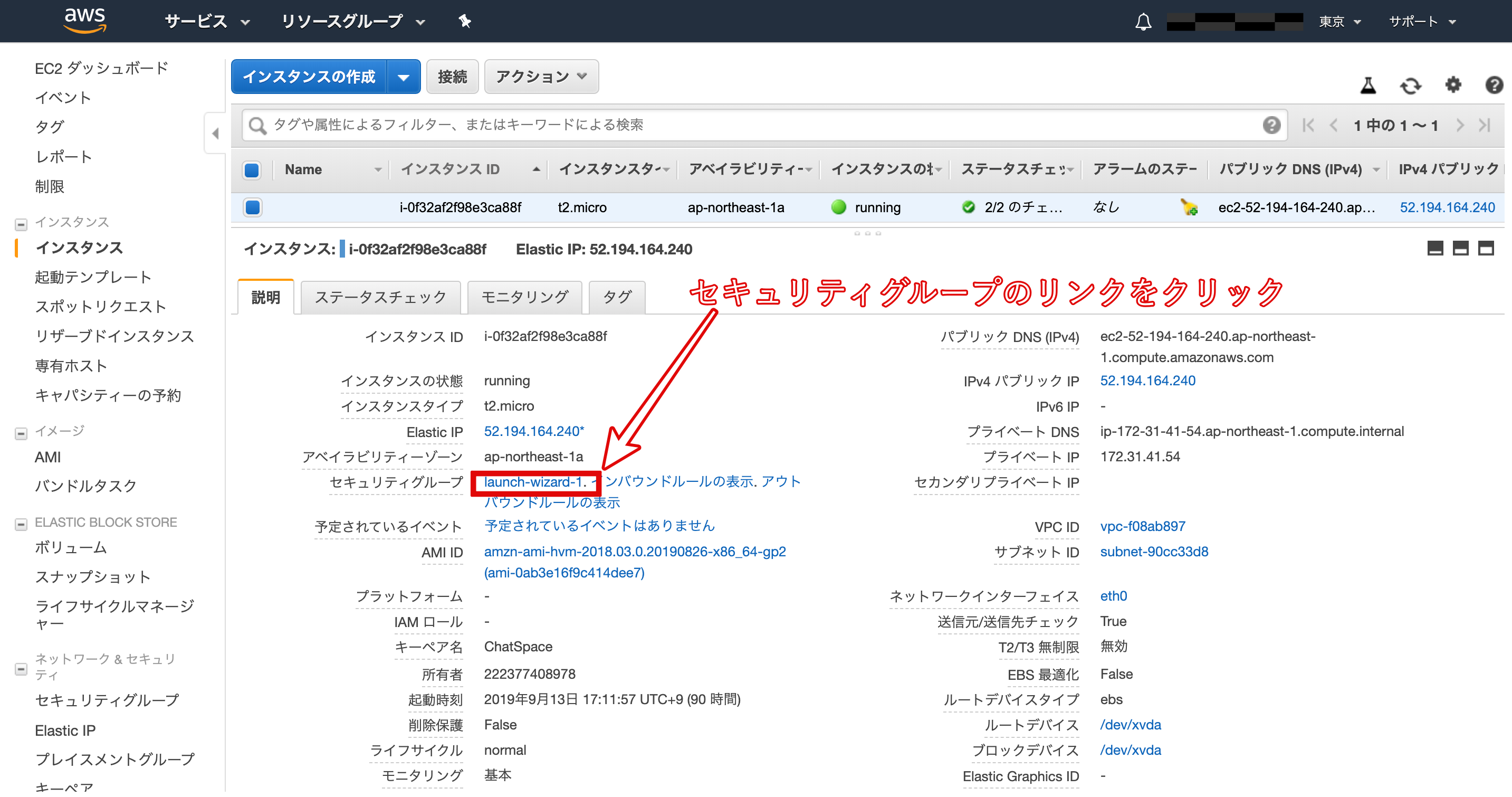

「セキュリティグループ」のリンクlaunch-wizard-1をクリックします。

「ルールの追加」をクリックします。

タイプを「HTTP」、プロトコルを「TCP」、ポート範囲を「80」、送信元を「カスタム / 0.0.0.0/0, ::/0」に設定します。「0.0.0.0」や「::/0」は「全てのアクセスを許可する」という意味です。

- EC2インスタンスへのログイン

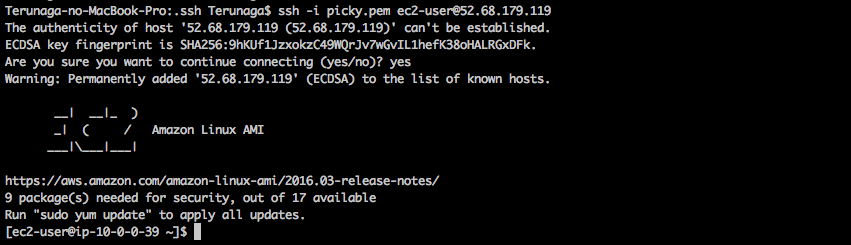

EC2インスタンスを作成すると、ec2-userというユーザーと対応するSSH秘密鍵が生成されました。

ターミナルで以下のコマンドを実行しましょう。ターミナル(ローカル)$ cd ~ $ mkdir ~/.ssh # .sshというディレクトリを作成 # File existsとエラーが表示されたとしても、.sshディレクトリは存在しているということなので、そのまま進みましょう。 $ mv Downloads/ダウンロードした鍵の名前.pem .ssh/ # mvコマンドで、ダウンロードしたpemファイルを、ダウンロードディレクトリから、.sshディレクトリに移動します。 $ cd .ssh/ $ ls # pemファイルが存在するか確認しましょう $ chmod 600 ダウンロードした鍵の名前.pem $ ssh -i ダウンロードした鍵の名前.pem ec2-user@作成したEC2インスタンスと紐付けたElastic IP #(例えばElastic IPが123.456.789であれば、shh -i ダウンロードした鍵の名前.pem ec2-user@123.456.789 というコマンドになります) #(ダウンロードした鍵を用いて、ec2-userとしてログイン)Elastic IP は各自のAWSアカウントから確認してください。

以下の様なメッセージが表示されることがありますが、「yes」と入力して下さい。ターミナル(ローカル)$ ssh -i aws_key.pem ec2-user@52.68.~~~~~~ The authenticity of host '52.68.~~~~~~ (52.68.~~~~~~)' can't be established. RSA key fingerprint is eb:7a:bd:e6:aa:da:~~~~~~~~~~~~~~~~~~~~~~~~. Are you sure you want to continue connecting (yes/no)?ターミナルのコマンド待ちの際の左側の表示が、以下の画像のように

[ec2-user| ...以上で、AWSの設定とEC2インスタンスの生成が完了でございます。

- 必要なツールのインストール

ターミナルで以下のコマンドを実行しパッケージをアップデートしましょう。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo yum -y update次に、その他環境構築に必要なパッケージを諸々インストールします。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo yum -y install git make gcc-c++ patch libyaml-devel libffi-devel libicu-devel zlib-devel readline-devel libxml2-devel libxslt-devel ImageMagick ImageMagick-devel openssl-devel libcurl libcurl-devel curlちなみに-y はyumコマンドのオプションで全ての問いにYesで自動的に答えるという意味だぞ❤️

- Node.jsをインストール

サーバーサイドで動くJavaScriptのパッケージです。今後のデプロイに向けた作業の中で、CSSや画像を圧縮する際に活用されます。ターミナルでNode.jsをインストールしましょう。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo curl -sL https://rpm.nodesource.com/setup_6.x | sudo bash - [ec2-user@ip-172-31-25-189 ~]$ sudo yum -y install nodejs

- rbenvとruby-buildをインストール

ターミナルでrbenvとruby-buildをインストールしましょう。

ターミナル(EC2サーバー)#rbenvのインストール [ec2-user@ip-172-31-25-189 ~]$ git clone https://github.com/sstephenson/rbenv.git ~/.rbenv #パスを通す [ec2-user@ip-172-31-25-189 ~]$ echo 'export PATH="$HOME/.rbenv/bin:$PATH"' >> ~/.bash_profile #rbenvを呼び出すための記述 [ec2-user@ip-172-31-25-189 ~]$ echo 'eval "$(rbenv init -)"' >> ~/.bash_profile #.bash_profileの読み込み [ec2-user@ip-172-31-25-189 ~]$ source .bash_profile #ruby-buildのインストール [ec2-user@ip-172-31-25-189 ~]$ git clone https://github.com/sstephenson/ruby-build.git ~/.rbenv/plugins/ruby-build #rehashを行う [ec2-user@ip-172-31-25-189 ~]$ rbenv rehash

- Rubyをインストール

自身のアプリケーションで使っているRubyのバージョンによって適宜変更してください。

ここでは、2.5.1をインストールしていきます。ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ rbenv install 2.5.1 [ec2-user@ip-172-31-25-189 ~]$ rbenv global 2.5.1 [ec2-user@ip-172-31-25-189 ~]$ rbenv rehash #rehashを行う [ec2-user@ip-172-31-25-189 ~]$ ruby -v # バージョンを確認

- MySQLをインストール

Amazon Linuxを利用している場合、MySQLは yum コマンドからインストールすることができます。

以下のコマンドを実行してください。ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo yum -y install mysql56-server mysql56-devel mysql56これは、MySQLのバージョン5.6をインストールすることを意味します。

- MySQLを起動しよう

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo service mysqld startmysql ではなく mysqld であることに注意しましょう。「d」はLinuxの用語で「サーバ」を意味する「デーモン(daemon)」の頭文字です。

起動できたか確認するために、以下のコマンドを打ってみましょう。ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo service mysqld status mysqld (pid 15692) is running...「running」と表示されれば、MySQLの起動は成功です。

- MySQLのrootパスワードの設定

以下のコマンドでパスワードを設定しましょう。'設定したいパスワード'の部分については、例えばpassword0000という文字列を設定するとしたら、 'password0000'と記載しましょう。

※0から始まるpasswordは読み込んでくれないケースが多いので、避けましょう!ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo /usr/libexec/mysql56/mysqladmin -u root password 'ここを設定したいパスワードに変更してからコマンドを実行してください'このパスワードは、後ほどRailsからアクセスする時にも利用するので記憶しておいてください。

この時、Warning: Using a password on the command line interface can be insecure.

と警告がでることがありますが、ここでは無視していただいて問題ありません。設定したパスワードが使えるか確認してみましょう。以下のコマンドを入力してください。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ mysql -u root -pEnter password: とパスワードを入力するように表示されるので、先程設定したパスワードを入力して、Enterしてください。以下のように表示されれば、MySQLの設定は終了です。

ターミナル(EC2サーバー)Welcome to the MySQL monitor. Commands end with ; or \g. Your MySQL connection id is 4 Server version: 5.6.33 MySQL Community Server (GPL) Copyright (c) 2000, 2016, Oracle and/or its affiliates. All rights reserved. Oracle is a registered trademark of Oracle Corporation and/or its affiliates. Other names may be trademarks of their respective owners. Type 'help;' or '\h' for help. Type '\c' to clear the current input statement. mysql>以上で、各ツールのインストールが完了でございます。

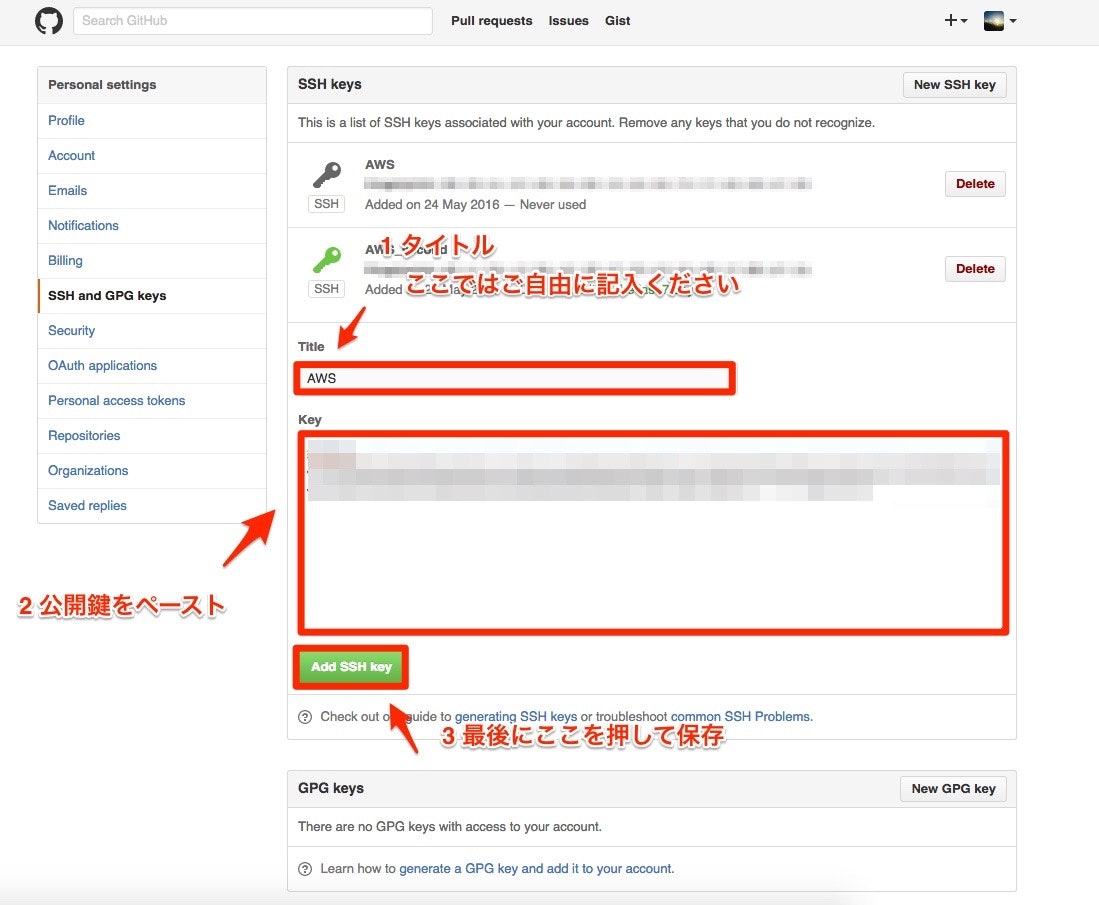

- EC2のサーバにGithubのコードをクローン

現状、EC2サーバにアプリケーションのコードをクローンしようとしてもpermission deniedとエラーが出てしまいます。

これは、Githubから見てこのEC2インスタンスが何者かわからないためです。

以下のコマンド入力して、EC2サーバのSSH鍵ペアを作成しましょう。ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 ~]$ ssh-keygen -t rsa -b 4096 Generating public/private rsa key pair. Enter file in which to save the key (/home/ec2-user/.ssh/id_rsa): Enter passphrase (empty for no passphrase): Enter same passphrase again: Your identification has been saved in /home/ec2-user/.ssh/id_rsa. Your public key has been saved in /home/ec2-user/.ssh/id_rsa.pub. The key fingerprint is: 3a:8c:1d:d1:a9:22:c7:6e:6b:43:22:31:0f:ca:63:fa ec2-user@ip-172-31-23-189 The key's randomart image is: +--[ RSA 4096]----+ | + | | . . = | | = . o . | | * o . o | |= * S | |.* + . | | * + | | .E+ . | | .o | +-----------------+次に、以下のコマンドで生成されたSSH公開鍵を表示し、値をコピーします。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 ~]$ cat ~/.ssh/id_rsa.pub ssh-rsa AAAAB3NzaC1yc2E......そして、catで表示させた公開鍵を、Githubにアクセスして登録していきます。

まず、以下のURLにアクセスしてください。

https://github.com/settings/keys

Githubに鍵を登録できたら、SSH接続できるか以下のコマンドで確認してみましょう。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 ~]$ ssh -T git@github.com Hi <Githubユーザー名>! You've successfully authenticated, but GitHub does not provide shell access.途中でこのまま続けるかどうかYes/Noで聞かれることがありますが、Yesで進んでください。

Permission denied (publickey).

と表示された場合は、SSH鍵の設定が間違っているので、作業を確認してください。unicornの導入

unicornは rails s の代わりを担ってくれるアプリケーションサーバです。(アバウトすぎw)

- Unicornをインストール

次のように ローカルでGemfile を編集しましょう。

Gemfilegroup :production do gem 'unicorn', '5.4.1' endローカルのrails newしたディレクトリでbundle installコマンドを実行してください。

ターミナル(ローカル)$ bundle installconfig/unicorn.rbを作成し、内容を以下のように編集して保存しましょう。

config/unicorn.rb#サーバ上でのアプリケーションコードが設置されているディレクトリを変数に入れておく app_path = File.expand_path('../../', __FILE__) #アプリケーションサーバの性能を決定する worker_processes 1 #アプリケーションの設置されているディレクトリを指定 working_directory app_path #Unicornの起動に必要なファイルの設置場所を指定 pid "#{app_path}/tmp/pids/unicorn.pid" #ポート番号を指定 listen 3000 #エラーのログを記録するファイルを指定 stderr_path "#{app_path}/log/unicorn.stderr.log" #通常のログを記録するファイルを指定 stdout_path "#{app_path}/log/unicorn.stdout.log" #Railsアプリケーションの応答を待つ上限時間を設定 timeout 60 #以下は応用的な設定なので説明は割愛 preload_app true GC.respond_to?(:copy_on_write_friendly=) && GC.copy_on_write_friendly = true check_client_connection false run_once = true before_fork do |server, worker| defined?(ActiveRecord::Base) && ActiveRecord::Base.connection.disconnect! if run_once run_once = false # prevent from firing again end old_pid = "#{server.config[:pid]}.oldbin" if File.exist?(old_pid) && server.pid != old_pid begin sig = (worker.nr + 1) >= server.worker_processes ? :QUIT : :TTOU Process.kill(sig, File.read(old_pid).to_i) rescue Errno::ENOENT, Errno::ESRCH => e logger.error e end end end after_fork do |_server, _worker| defined?(ActiveRecord::Base) && ActiveRecord::Base.establish_connection end

- デプロイ時のエラー対策

Uglifierというgemがあり、これはJavaScriptを軽量化するためのものです。しかし、ChatSpaceのJavaScriptで使用しているテンプレートリテラル記法(`)に対応していません。そのため、デプロイ時にエラーの原因となります。

デプロイ時にエラーの原因となる記述の対策として、下記のフォルダを編集しましょう。config/environments/production.rb(修正前)config.assets.js_compressor = :uglifierconfig/environments/production.rb(修正後)# config.assets.js_compressor = :uglifier

- 変更修正をリモートリポジトリに反映

ここまで、ローカルのフォルダ内で変更修正を行ったので、GitHub Desktopからコミットしてプッシュしましょう。この時必ず、masterブランチで行うようにしてください。もし、別ブランチでコミット&プッシュした場合は、リモートリポジトリでプルリクエストを作成し、ブランチをmasterへマージしてください。

- Githubからコードをクローン

続いて、Unicornの設定を済ませたコードをEC2インスタンスにクローンしましょう。

まず、以下のコマンドを入力して、ディレクトリを作成します。今回は、ここで作成したディレクトリにアプリケーションを設置することにします。ターミナル(EC2サーバー)#mkdirコマンドで新たにディレクトリを作成 [ec2-user@ip-172-31-23-189 ~]$ sudo mkdir /var/www/ #作成したwwwディレクトリの権限をec2-userに変更 [ec2-user@ip-172-31-23-189 ~]$ sudo chown ec2-user /var/www/取得した「リポジトリURL」を使って、コードをクローンします。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 ~]$ cd /var/www/ [ec2-user@ip-172-31-23-189 www]$ git clone https://github.com/<ユーザー名>/<リポジトリ名>.git

- Swap領域を用意

コンピュータが処理を行う際、メモリと呼ばれる場所に処理内容が一時的に記録されます。メモリは容量が決まっており、容量を超えてしまうとエラーで処理が止まってしまいます。Swap領域は、メモリが使い切られそうになった時にメモリの容量を一時的に増やすために準備されるファイルです。

まずは、ホームディレクトリに移動します。

ターミナル(EC2サーバー)#ホームディレクトリに移動 [ec2-user@ip-172-31-25-189 ~]$ cd続いて、以下の順番でコマンドを実行します。

ターミナル(EC2サーバー)#処理に時間がかかる可能性があるコマンドです [ec2-user@ip-172-31-25-189 ~]$ sudo dd if=/dev/zero of=/swapfile1 bs=1M count=512 # しばらく待って、以下のように表示されれば成功 512+0 レコード入力 512+0 レコード出力 536870912 バイト (537 MB) コピーされました、 7.35077 秒、 73.0 MB/秒ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo chmod 600 /swapfile1ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo mkswap /swapfile1 # 以下のように表示されれば成功 スワップ空間バージョン1を設定します、サイズ = 524284 KiB ラベルはありません, UUID=74a961ba-7a33-4c18-b1cd-9779bcda8ab1ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo swapon /swapfile1ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo sh -c 'echo "/swapfile1 none swap sw 0 0" >> /etc/fstab'※最後のコードは見づらくなっていますが、「/swapfile1 none」より右に続きがありますのでご注意ください。

これで、Swap領域を確保することができました。

- クローンしたディレクトリに移動し、 rbenvでインストールされたRubyが使われているかチェック

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 www]$ cd /var/www/<リポジトリ名> [ec2-user@ip-172-31-23-189 <リポジトリ名>]$ ruby -v ruby 2.5.1p112 (2016-04-26 revision 54768) [x86_64-linux]ruby 2.5.1 ...となっていれば成功です。そうでない場合は、もともと用意されているRubyが利用されているので、Rubyのインストールが成功しているか確認してください。

- bundlerをインストール

まず今まで開発環境(ローカル)で開発してきたアプリにおいて、どのバージョンのbundlerが使われていたのか確認します。

ターミナル(ローカル)#アプリのディレクトリで以下を実行 $ bundler -v Bundler version 2.0.1 # 開発環境によってバージョンは異なります。開発環境で仕様しているbundlerのバージョンがわかったので、同じバージョンのものをEC2サーバ側にも導入します。上記の場合では、bundler 2.0.1のバージョンを導入して bundle install を実行します。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ gem install bundler -v 2.0.1 # ローカルで確認したbundlerのバージョンを導入する [ec2-user@ip-172-31-23-189 <リポジトリ名>]$ bundle install # 上記コマンドは、数分以上かかる場合もあります。

- 環境変数の設定

データベースのパスワードなどセキュリティのためにGithubにアップロードすることができない情報は、環境変数というものを利用して設定します。

- secret_key_base

secret_key_baseとは、Cookieの暗号化に用いられる文字列です。Railsアプリケーションを動作させる際は必ず用意する必要があります。また、外部に漏らしてはいけない値であるため、こちらも環境変数から参照します。

以下のコマンドを打つことで生成できます。ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ rake secret 69619d9a75b78f2e1c87ec5e07541b42f23efeb6a54e97da3723de06fe74af29d5718adff77d2b04b2805d3a1e143fa61baacfbf4ca2c6fcc608cff8d5a28e8dこの長い英数の羅列は、この後利用するのでコピーしておきましょう。

- 実際にEC2インスタンスに環境変数を設定

環境変数は /etc/environment というファイルに保存することで、サーバ全体に適用されます。環境変数の書き込みはvimコマンドを使用して行います。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 ~]$ sudo vim /etc/environmentiと打ち込んで入力モードに切り替えた後、下記の記述を打ち込みます。=の前後にスペースは入れません。

/etc/environment#先程設定したMySQLのrootユーザーのパスワードを入力 DATABASE_PASSWORD='MySQLのrootユーザーのパスワード' SECRET_KEY_BASE='先程コピーしたsecret_key_base'入力ができたら、escキーを押した後、:wqで保存しましょう。

- 設定した環境変数を反映させるために、一度本番環境をログアウト

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 ~]$ exit logout Connection to 52.xx.xx.xx closed.

- もう一度本番環境へログイン

ターミナル(ローカル)$ ssh -i [ダウンロードした鍵の名前].pem ec2-user@[作成したEC2インスタンスと紐付けたElastic IP] (ダウンロードした鍵を用いて、ec2-userとしてログイン)

- 設定した環境変数が本当に適用されているか確認

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 ~]$ env | grep SECRET_KEY_BASE SECRET_KEY_BASE='secret_key_base' [ec2-user@ip-172-31-23-189 ~]$ env | grep DATABASE_PASSWORD DATABASE_PASSWORD='MySQLのrootユーザーのパスワード'

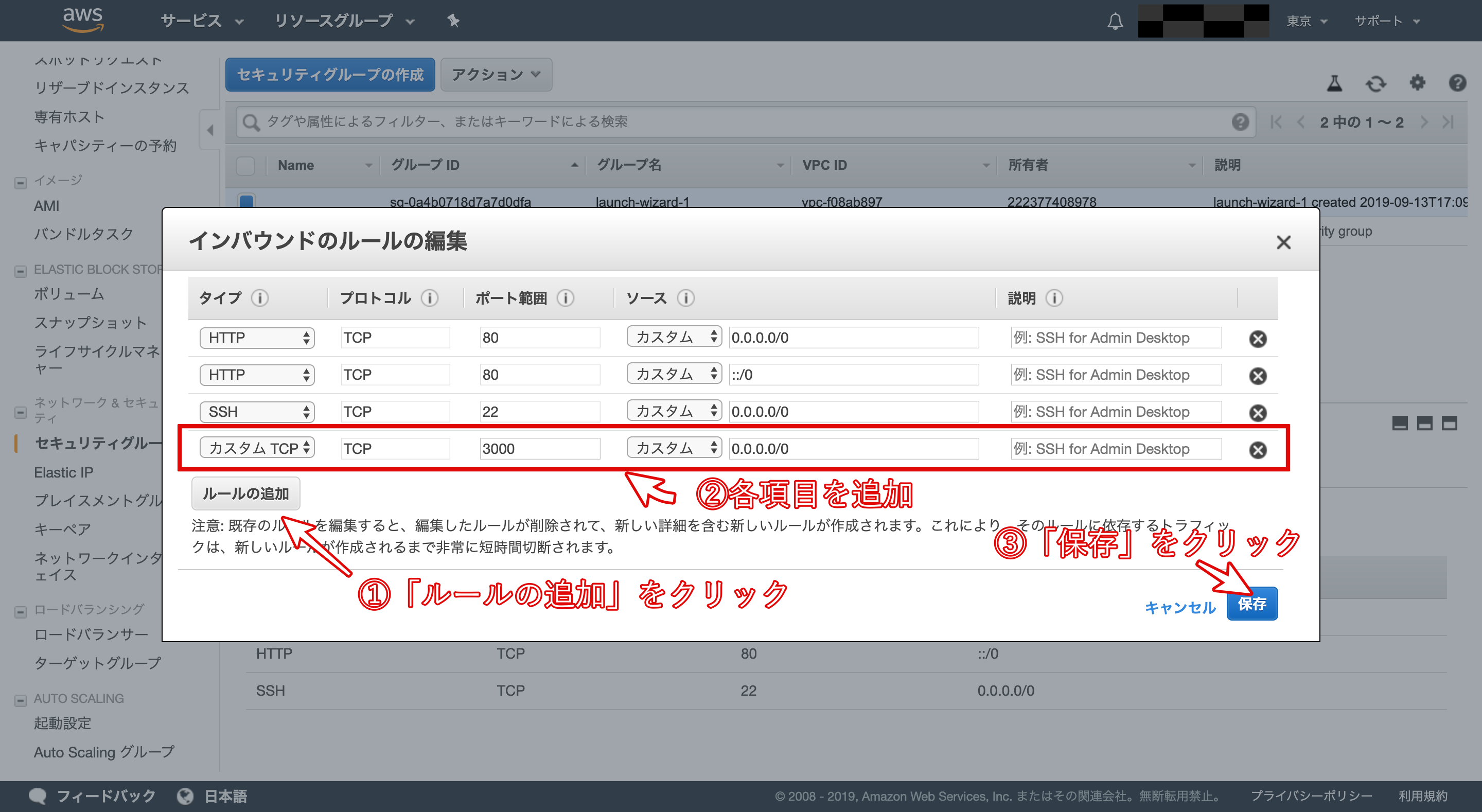

- ポート解放2

先程、 config/unicorn.rb に listen 3000を設定しました。そのため、WEBサーバとして利用するEC2インスタンスは事前にHTTPがつながるように「ポート」を開放する必要があります。

「セキュリティグループ」のリンクlaunch-wizard-1をクリックします。

「ルールの追加」をクリックします。

タイプを「カスタムTCPルール」、プロトコルを「TCP」、ポート範囲を「3000」、送信元を「カスタム」「0.0.0.0/0」に設定します。

以上で、ポートの開放が完了です。

この作業が終わっていないと、起動したRailsにアクセスできないので注意してください。

- Railsを起動する

いよいよRailsの起動です。

以下のコマンドを実行し、ユニコーンを起動ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 ~]$ cd /var/www/[リポジトリ名] [ec2-user@ip-172-31-23-189 <リポジトリ名>]$ bundle exec unicorn_rails -c config/unicorn.rb -E production -Dこのコマンドを実行すると、以下のようにすぐにコマンドが終了してしまいます。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ bundle exec unicorn_rails -c config/unicorn.rb -E production -D master failed to start, check stderr log for detailsなので、Unicornのエラーログを確認しましょう。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ less log/unicorn.stderr.log I, [2016-12-21T04:01:19.135154 #18813] INFO -- : Refreshing Gem list I, [2016-12-21T04:01:20.732521 #18813] INFO -- : listening on addr=0.0.0.0:3000 fd=10 E, [2016-12-21T04:01:20.734067 #18813] ERROR -- : Can't connect to local MySQL server through socket '/tmp/mysql.sock' (2) /home/ec2-user/.rbenv/versions/2.5.1/lib/ruby/gems/2.5.0/gems/activerecord-5.0.0.1/lib/active_record/connection_adapters/mysql2_adapter.rb:29:in `rescue in mysql2_connection' /home/ec2-user/.rbenv/versions/2.5.1/lib/ruby/gems/2.5.0/gems/activerecord-5.0.0.1/lib/active_record/connection_adapters/mysql2_adapter.rb:12:in `mysql2_connection' /home/ec2-user/.rbenv/versions/2.5.1/lib/ruby/gems/2.3.0/gems/activerecord-5.0.0.1/lib/active_record/connection_adapters/abstract/connection_pool.rb:721:in `new_connection' /home/ec2-user/.rbenv/versions/2.5.1/lib/ruby/gems/2.5.0/gems/activerecord-5.0.0.1/lib/active_record/connection_adapters/abstract/connection_pool.rb:765:in `checkout_new_connection' /home/ec2-user/.rbenv/versions/2.5.1/lib/ruby/gems/2.5.0/gems/activerecord-5.0.0.1/lib/active_record/connection_adapters/abstract/connection_pool.rb:744:in `try_to_checkout_new_connection' /home/ec2-user/.rbenv/versions/2.5.1/lib/ruby/gems/2.5.0/gems/activerecord-5.0.0.1/lib/active_record/connection_adapters/abstract/connection_pool.rb:705:in `acquire_connection' /home/ec2-user/.rbenv/versions/2.5.1/lib/ruby/gems/2.5.0/gems/activerecord-5.0.0.1/lib/active_record/connection_adapters/abstract/connection_pool.rb:501:in `checkout' /home/ec2-user/.rbenv/versions/2.5.1/lib/ruby/gems/2.5.0/gems/activerecord-5.0.0.1/lib/active_record/connection_adapters/abstract/connection_pool.rb:364:in `connection' /home/ec2-user/.rbenv/versions/2.5.1/lib/ruby/gems/2.5.0/gems/activerecord-5.0.0.1/lib/active_record/connection_adapters/abstract/connection_pool.rb:875:in `retrieve_connection' /home/ec2-user/.rbenv/versions/2.5.1/lib/ruby/gems/2.5.0/gems/activerecord-5.0.0.1/lib/active_record/connection_handling.rb:128:in `retrieve_connection' /home/ec2-user/.rbenv/versions/2.5.1/lib/ruby/gems/2.5.0/gems/activerecord-5.0.0.1/lib/active_record/connection_handling.rb:91:in `connection' config/unicorn.rb:36:in `block in reload' /home/ec2-user/.rbenv/versions/2.5.1/lib/ruby/gems/2.5.0/gems/unicorn-5.1.0/lib/unicorn/http_server.rb:502:in `spawn_missing_workers' /home/ec2-user/.rbenv/versions/2.5.1/lib/ruby/gems/2.5.0/gems/unicorn-5.1.0/lib/unicorn/http_server.rb:132:in `start' /home/ec2-user/.rbenv/versions/2.5.1/lib/ruby/gems/2.5.0/gems/unicorn-5.1.0/bin/unicorn_rails:209:in `<top (required)>' /home/ec2-user/.rbenv/versions/2.5.1/bin/unicorn_rails:23:in `load' /home/ec2-user/.rbenv/versions/2.5.1/bin/unicorn_rails:23:in `<main>'このERRORという行を見てみると、これは本番環境でインストールするmysqlの設定がローカルとは異なるため、mysqlへ接続できなくなっている状態です。

database.ymlの本番環境の設定を編集

config/database.yml(ローカル)production: <<: *default database: <リポジトリ名>_production(それぞれのアプリケーション名によって異なっています。) username: root password: <%= ENV['DATABASE_PASSWORD'] %> socket: /var/lib/mysql/mysql.sockローカルでの編集をコミットして、GitHubにプッシュ。

サーバ上のアプリケーションにも反映させたいので、以下のようにコマンドを実行してください。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>] git pull origin masterデータベースを作成しマイグレーションを実行し直し。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ rails db:create RAILS_ENV=production Created database '<データベース名>' [ec2-user@ip-172-31-23-189 <リポジトリ名>]$ rails db:migrate RAILS_ENV=productionもしここでMysql2::Error: Can't connect to local MySQL server through socket '/var/lib/mysql/mysql.sock'というエラーが起こった場合、mysqlが起動していない可能性があります。sudo service mysqld startというコマンドをターミナルから打ち込み、mysqlの起動を試してみましょう。

再度Railsを起動。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ bundle exec unicorn_rails -c config/unicorn.rb -E production -Dブラウザで http://<サーバに紐付けたElastic IP>:3000/ にアクセスしてみましょう。

ブラウザにCSSの反映されていない(ビューが崩れている)画面が表示されていれば成功です。アセットファイルをコンパイル

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ rails assets:precompile RAILS_ENV=productionコンパイルが成功したら反映を確認するため、Railsを再起動したいので今動いているUnicornをストップ&スタートします。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ ps aux | grep unicorn ...すると、以下のようにプロセスが表示されるはずです。

ターミナル(EC2サーバー)ec2-user 17877 0.4 18.1 588472 182840 ? Sl 01:55 0:02 unicorn_rails master -c config/unicorn.rb -E production -D ec2-user 17881 0.0 17.3 589088 175164 ? Sl 01:55 0:00 unicorn_rails worker[0] -c config/unicorn.rb -E production -D ec2-user 17911 0.0 0.2 110532 2180 pts/0 S+ 02:05 0:00 grep --color=auto unicornkillコマンドを入力してUnicornのプロセスを停止

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ kill <確認したunicorn rails masterのPID> ...再度、プロセスを表示させ終了できていることを確認しましょう。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ ps aux | grep unicorn ... ec2-user 17911 0.0 0.2 110532 2180 pts/0 S+ 02:05 0:00 grep --color=auto unicorn下記の2行が表示が消えていない場合はプロセスが終了できていないことになります。

ターミナル(EC2サーバー)ec2-user 17877 0.4 18.1 588472 182840 ? Sl 01:55 0:02 unicorn_rails master -c config/unicorn.rb -E production -D ec2-user 17881 0.0 17.3 589088 175164 ? Sl 01:55 0:00 unicorn_rails worker[0] -c config/unicorn.rb -E production -Dそのような場合は、プロセスを強制終了しましょう。オプション-9をkillコマンドにつけると強制終了を実行できます。通常のkillコマンドで削除できない場合はこちらを使用しましょう。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ kill -9 [プロセスID] #プロセスIDはpsコマンドで検索した結果の数字に置き換えてください。上記であれば17877です。unicornを起動

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ RAILS_SERVE_STATIC_FILES=1 unicorn_rails -c config/unicorn.rb -E production -D ...もう一度、ブラウザで http://<Elastic IP>:3000/ にアクセスしてみましょう。今度はレイアウト崩れも無くサイトが正常に表示されていることでしょう。

nginxの導入

Nginx(エンジン・エックス)とは、Webサーバの一種です。

- Nginxをインストール

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo yum -y install nginx

- Nginxの設定ファイルを編集

vimコマンドを使ってターミナル上で編集していきます。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo vim /etc/nginx/conf.d/rails.confrails.confupstream app_server { # Unicornと連携させるための設定。アプリケーション名を自身のアプリ名に書き換えることに注意。今回であればおそらくchat-space server unix:/var/www/<アプリケーション名>/tmp/sockets/unicorn.sock; } # {}で囲った部分をブロックと呼ぶ。サーバの設定ができる server { # このプログラムが接続を受け付けるポート番号 listen 80; # 接続を受け付けるリクエストURL ここに書いていないURLではアクセスできない server_name <Elastic IP>; # クライアントからアップロードされてくるファイルの容量の上限を2ギガに設定。デフォルトは1メガなので大きめにしておく client_max_body_size 2g; # 接続が来た際のrootディレクトリ root /var/www/<アプリケーション名>/public; # assetsファイル(CSSやJavaScriptのファイルなど)にアクセスが来た際に適用される設定 location ^~ /assets/ { gzip_static on; expires max; add_header Cache-Control public; } try_files $uri/index.html $uri @unicorn; location @unicorn { proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header Host $http_host; proxy_redirect off; proxy_pass http://app_server; } error_page 500 502 503 504 /500.html; }以下の3点は書き換えが必須です。

3行目の<アプリケーション名> となっている箇所は、ご自身のものに変更してください。

11行目の<Elastic IP>となっている箇所も同様に、ご自身のものに変更してください。

14行目の<アプリケーション名> となっている箇所は、ご自身のものに変更してください。※この場合<>は記入不要なもの/表示されないものとして捉えてください。説明のための日本語文字列を明示するために<>で囲んでいます。

- nginxの権限を変更

設定が完了したら、POSTメソッドでもエラーが出ないようにするために、下記のコマンドも実行してください。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ cd /var/lib [ec2-user@ip-172-31-25-189 lib]$ sudo chmod -R 775 nginxこれで、Nginxの設定が完了しました。

- Nginxを再起動して設定ファイルを再読み込み

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 lib]$ cd ~ [ec2-user@ip-172-31-25-189 ~]$ sudo service nginx restart

- ローカルでunicorn.rbを修正

次にNginxを介した処理を行うためにunicornの設定を修正します。

unicorn.rb(ローカル)listen 3000 ↓以下のように修正 listen "#{app_path}/tmp/sockets/unicorn.sock"ローカルで編集したファイルをリモートへpush

- ローカルの変更点を本番環境へ反映

ターミナル(EC2サーバー)# まず、chat-spaceのディレクトリに移動 [ec2-user@ip-172-31-25-189 ~]$ cd /var/www/chat-space [ec2-user@ip-172-31-23-189 <レポジトリ名>]$ git pull origin master

- Unicornを再起動

まず、プロセスの番号を確認します。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ ps aux | grep unicorn ec2-user 17877 0.4 18.1 588472 182840 ? Sl 01:55 0:02 unicorn_rails master -c config/unicorn.rb -E production -D ec2-user 17881 0.0 17.3 589088 175164 ? Sl 01:55 0:00 unicorn_rails worker[0] -c config/unicorn.rb -E production -D ec2-user 17911 0.0 0.2 110532 2180 pts/0 S+ 02:05 0:00 grep --color=auto unicorn続いて、プロセスをkillします。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ kill <確認したunicorn rails masterのPID(上のコードでは17877)> ...Unicornを起動します。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ RAILS_SERVE_STATIC_FILES=1 unicorn_rails -c config/unicorn.rb -E production -D ...

- ブラウザからElastic IPでアクセス

ブラウザからElastic IPでアクセスすると、アプリケーションにアクセスできます(:3000をつける必要はありません)。なお、この時もunicornが起動している必要があります。

capistranoの導入

capistranoは、自動デプロイツールと呼ばれるものの一種です。自動デプロイツールを利用することによって、デプロイ時に必要なコマンド操作が1回で済むようになります。

- capistranoを利用するためのGemをインストール

gemfile(ローカル)group :development, :test do gem 'capistrano' gem 'capistrano-rbenv' gem 'capistrano-bundler' gem 'capistrano-rails' gem 'capistrano3-unicorn' end続いて、Gemfileを読み込みましょう。

ターミナル(ローカル)bundle installgemを読み込めたら、下記のコマンドを打ちます。

ターミナル(ローカル)bundle exec cap installすると、下記のようにファイルが生成されます。

アプリケーション名

?capfile

?config

?deploy

?production.rb

?staging.rb

?deploy.rb

?lib

?capistrano

?tasks

- Capfileを編集

capfilerequire "capistrano/setup" require "capistrano/deploy" require 'capistrano/rbenv' require 'capistrano/bundler' require 'capistrano/rails/assets' require 'capistrano/rails/migrations' require 'capistrano3/unicorn' Dir.glob("lib/capistrano/tasks/*.rake").each { |r| import r }

- production.rbを下記のように編集

config/deploy/production.rbserver '<用意したElastic IP>', user: 'ec2-user', roles: %w{app db web}

- 下記の指示に従い、deploy.rbを編集

deploy.rbの記述をすべて削除し、以下のコードを貼り付けます。

config/deploy.rb# config valid only for current version of Capistrano # capistranoのバージョンを記載。固定のバージョンを利用し続け、バージョン変更によるトラブルを防止する lock '<Capistranoのバージョン>' # Capistranoのログの表示に利用する set :application, '<自身のアプリケーション名>' # どのリポジトリからアプリをpullするかを指定する set :repo_url, 'git@github.com:<Githubのユーザー名>/<レポジトリ名>.git' # バージョンが変わっても共通で参照するディレクトリを指定 set :linked_dirs, fetch(:linked_dirs, []).push('log', 'tmp/pids', 'tmp/cache', 'tmp/sockets', 'vendor/bundle', 'public/system', 'public/uploads') set :rbenv_type, :user set :rbenv_ruby, 2.5.1 #<このアプリで使用しているrubyのバージョン> # credentials.yml.encではmasterkeyにする set :linked_files, %w{config/master.key} # どの公開鍵を利用してデプロイするか set :ssh_options, auth_methods: ['publickey'], keys: ['<ローカルPCのEC2インスタンスのSSH鍵(pem)へのパス(例:~/.ssh/key_pem.pem)>'] # プロセス番号を記載したファイルの場所 set :unicorn_pid, -> { "#{shared_path}/tmp/pids/unicorn.pid" } # Unicornの設定ファイルの場所 set :unicorn_config_path, -> { "#{current_path}/config/unicorn.rb" } set :keep_releases, 5 # デプロイ処理が終わった後、Unicornを再起動するための記述 after 'deploy:publishing', 'deploy:restart' namespace :deploy do task :restart do invoke 'unicorn:stop' invoke 'unicorn:start' end desc 'upload master.key' task :upload do on roles(:app) do |host| if test "[ ! -d #{shared_path}/config ]" execute "mkdir -p #{shared_path}/config" end upload!('config/master.key', "#{shared_path}/config/master.key") end end before :starting, 'deploy:upload' after :finishing, 'deploy:cleanup' end以下の5点は書き換えが必須です。

- 3行目のはご自身のバージョンを記述しましょう。

- 6行目の<自身のアプリケーション名>はご自身のものを記述しましょう。

- 9行目の/<レポジトリ名>も同様に、ご自身のもの記述してください。

- 14行目の<このアプリで使用しているrubyのバージョン>はご自身のものを確認して記述してください。

- 21行目の<ローカルPCのEC2インスタンスのSSH鍵(pem)へのパス>も同様に、ご自身のもの記述してください。

- 以下の指示にしたがって、unicorn.rbの記述を編集

config/unicorn.rb#サーバ上でのアプリケーションコードが設置されているディレクトリを変数に入れておく app_path = File.expand_path('../../../', __FILE__) #アプリケーションサーバの性能を決定する worker_processes 1 #アプリケーションの設置されているディレクトリを指定 working_directory "#{app_path}/current" # それぞれ、sharedの中を参照するよう変更 listen "#{app_path}/shared/tmp/sockets/unicorn.sock" pid "#{app_path}/shared/tmp/pids/unicorn.pid" stderr_path "#{app_path}/shared/log/unicorn.stderr.log" stdout_path "#{app_path}/shared/log/unicorn.stdout.log" #Railsアプリケーションの応答を待つ上限時間を設定 timeout 60 #以下は応用的な設定なので説明は割愛 preload_app true GC.respond_to?(:copy_on_write_friendly=) && GC.copy_on_write_friendly = true check_client_connection false run_once = true before_fork do |server, worker| defined?(ActiveRecord::Base) && ActiveRecord::Base.connection.disconnect! if run_once run_once = false # prevent from firing again end old_pid = "#{server.config[:pid]}.oldbin" if File.exist?(old_pid) && server.pid != old_pid begin sig = (worker.nr + 1) >= server.worker_processes ? :QUIT : :TTOU Process.kill(sig, File.read(old_pid).to_i) rescue Errno::ENOENT, Errno::ESRCH => e logger.error e end end end after_fork do |_server, _worker| defined?(ActiveRecord::Base) && ActiveRecord::Base.establish_connection end

- 本番環境でのnginxの設定ファイルも変更

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo vim /etc/nginx/conf.d/rails.conf以下のように変更しましょう

rails.confupstream app_server { # sharedの中を参照するよう変更 server unix:/var/www/<アプリケーション名>/shared/tmp/sockets/unicorn.sock; } server { listen 80; server_name <Elastic IPを記入>; # クライアントからアップロードされてくるファイルの容量の上限を2ギガに設定。デフォルトは1メガなので大きめにしておく client_max_body_size 2g; # currentの中を参照するよう変更 root /var/www/<アプリケーション名>/current/public; location ^~ /assets/ { gzip_static on; expires max; add_header Cache-Control public; # currentの中を参照するよう変更 root /var/www/<アプリケーション名>/current/public; } try_files $uri/index.html $uri @unicorn; location @unicorn { proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header Host $http_host; proxy_redirect off; proxy_pass http://app_server; } error_page 500 502 503 504 /500.html; }もう一度記述すべき箇所が記述できているか確認しましょう。

- 3行目の<アプリケーション名> となっている箇所は、ご自身のものに変更してください。

- 11行目の<アプリケーション名>となっている箇所も同様に、ご自身のものに変更してください。

- 18行目の<アプリケーション名>となっている箇所も同様に、ご自身のものに変更してください。

Nginxの設定を変更したら、忘れずに再読込・再起動をしましょう。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo service nginx reload [ec2-user@ip-172-31-25-189 ~]$ sudo service nginx restart

- MySQLの起動を確認

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo service mysqld restart

- unicornのプロセスをkill

自動デプロイを実行する前にunicornのコマンドをkillしておきましょう。

まず、プロセスを確認します。ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ ps aux | grep unicorn ec2-user 17877 0.4 18.1 588472 182840 ? Sl 01:55 0:02 unicorn_rails master -c config/unicorn.rb -E production -D ec2-user 17881 0.0 17.3 589088 175164 ? Sl 01:55 0:00 unicorn_rails worker[0] -c config/unicorn.rb -E production -D ec2-user 17911 0.0 0.2 110532 2180 pts/0 S+ 02:05 0:00 grep --color=auto unicorn続いて、プロセスをkillします。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ kill <確認したunicorn rails masterのPID(上記では17877)> ...

- ローカルのcredentials.yml.encを編集

ここで注意したいのが、本番環境のcredentials.yml.encを編集すると、master.keyが自動生成されてしまい、ローカル環境のmester.keyが一致しなくなり、起動できなくなるので注意が必要です。

もし、本番環境のcredentials.yml.encを編集してしまった場合は、一度master.keyとcredentials.yml.encをコマンドで消去し、ローカルのcredentials.yml.encをpullしましょう。下記コマンドで暗号化されていない、credentials.yml.encを開くことができ、編集することができます。

ターミナル(ローカル)$ EDITOR=vim bin/rails credentials:editcredentials.yml.enc# S3使用時 # aws: # access_key_id: 123 # secret_access_key: 123 # Used as the base secret for all MessageVerifiers in Rails, including the one protecting cookies. secret_key_base: 先程コピーしたsecret_key_basesecret_key_baseは上記で作成したものを貼り付けましょう。

もし、忘れてしまった場合、本番環境での確認方法は下記の通りです。ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 ~]$ env | grep SECRET_KEY_BASE SECRET_KEY_BASE='secret_key_base'

- 本番環境のshared/configにmaster.keyを作成

このままデプロイしても以下のようなエラーが出てしまいます。

ターミナル(ローカル)ERROR linked file /var/www/techlog/shared/config/master.key does not exist on <Elastic IP>エラー通り、本番環境のshared/configにmaster.keyを作ります。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 ~]$ touch /var/www/アプリケーション名/shared/config/master.key作成したmaster.keyを編集します。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 ~]$ vim /var/www/アプリケーション名/shared/config/master.keyローカルのmaster.keyの内容をコピーし、本番環境のmaster.keyにコピーします。

以上で編集作業完了です。

- 最後に魔法の一文

ローカルで下記のコマンドを入力すると、自動デプロイを実行できます。

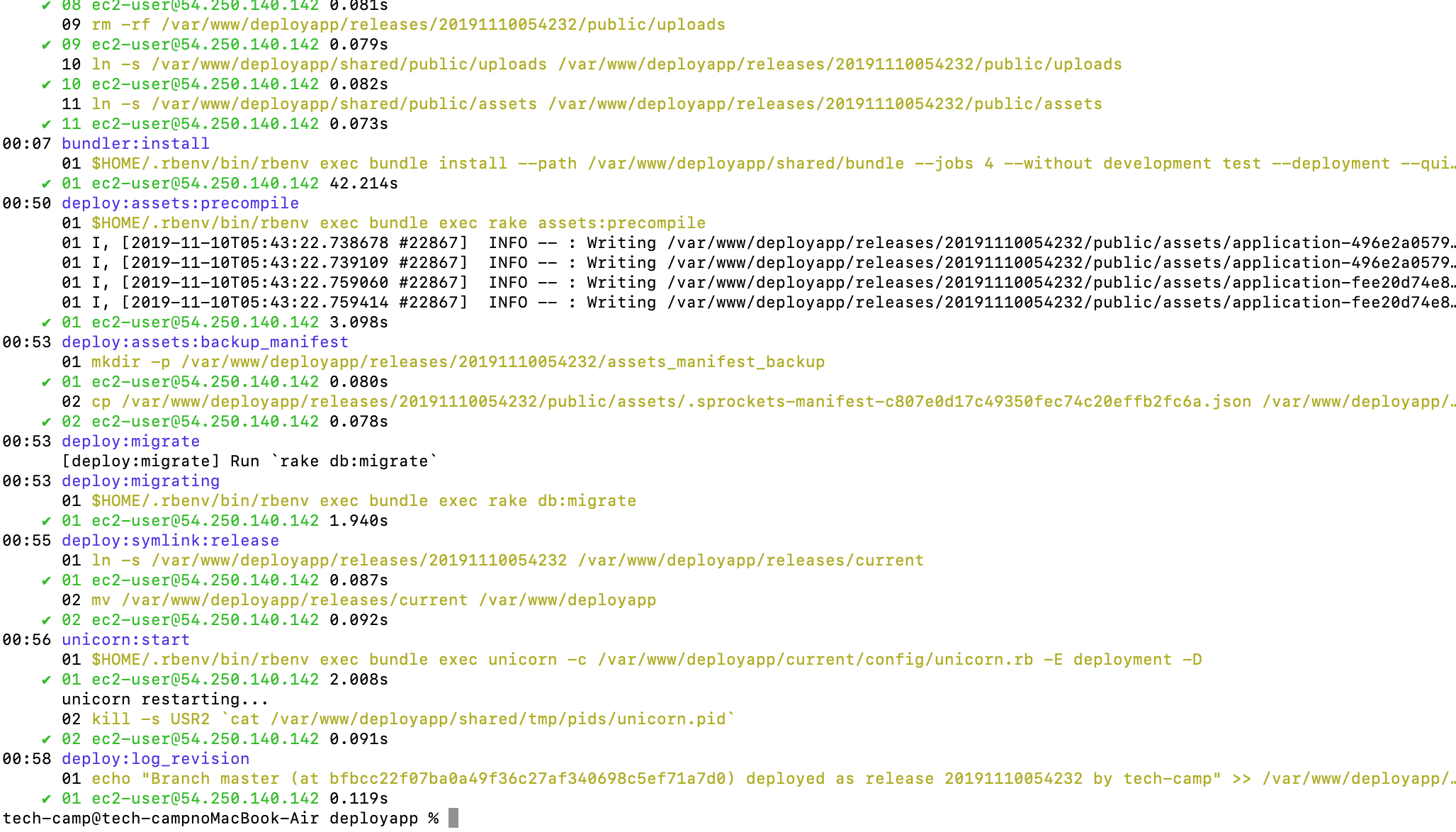

ターミナル(ローカル)# アプリケーションのディレクトリで実行する $ bundle exec cap production deploy上記コマンドを実行し、以下の画像のようにエラーが表示されずに完了したら自動デプロイは完了です。

もし、途中でエラーが出て止まってしまった場合は、以下を試します。

- そのままもう一度同じコマンドを実行してみる 特に、bundle installのタスクの際に、初めて自動デプロイを実行する場合は、メモリ不足で落ちることがあります

- 記述ミスが無いか 特に、本カリキュラムにおいて、修正したファイルに注目して確認しましょう

- 手順を飛ばしていないか bundle installなどのコマンド実行を忘れていないか確認しましょう

- ブラウザからElastic IPでアクセス

ブラウザからElastic IPでアクセスすると、アプリケーションにアクセスできます(:3000をつける必要はありません)。正しく動いていることを確認しましょう。

確認できればデプロイは一旦完了です。長時間お疲れ様でした!

お名前.comでドメインを購入し、AWSと紐付け

大まかな流れです。

- お名前.comでドメインを購入

- route53にDNSの設定と、ElasticIPの登録

- お名前ドットコムにroute53の情報を登録

では参りましょう!

- お名前.comでドメインを購入

お名前.comでアカウント登録と取得したいドメインを購入しましょう。

年単位での契約になります。

- route53とは

AWSのDNSサービスで、AWS上の各サービスを独自ドメインで利用する上で便利な機能が用意されていて親和性が高いサービスになっています。

- route53の設定!

route53にログイン

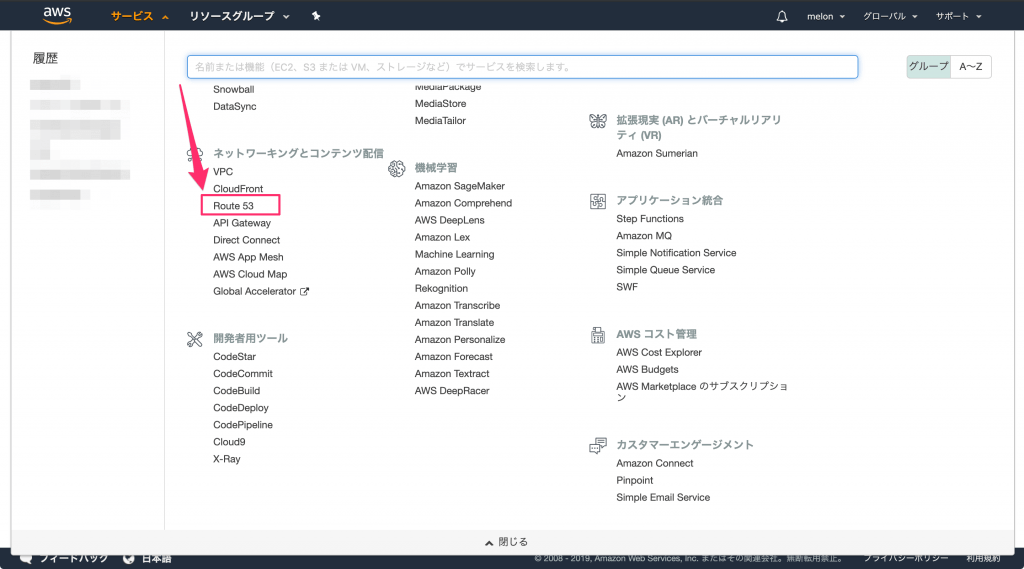

awsマネジメントコンソールのサービスから、Route 53を開きます。

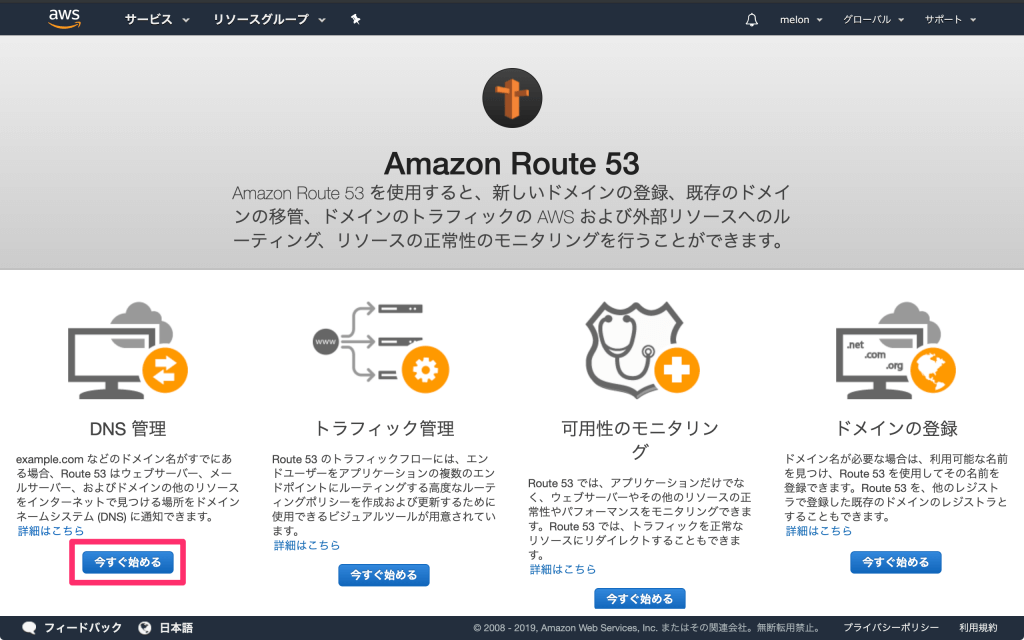

DNS管理のところにある「今すぐ始める」ボタンを押していきます。

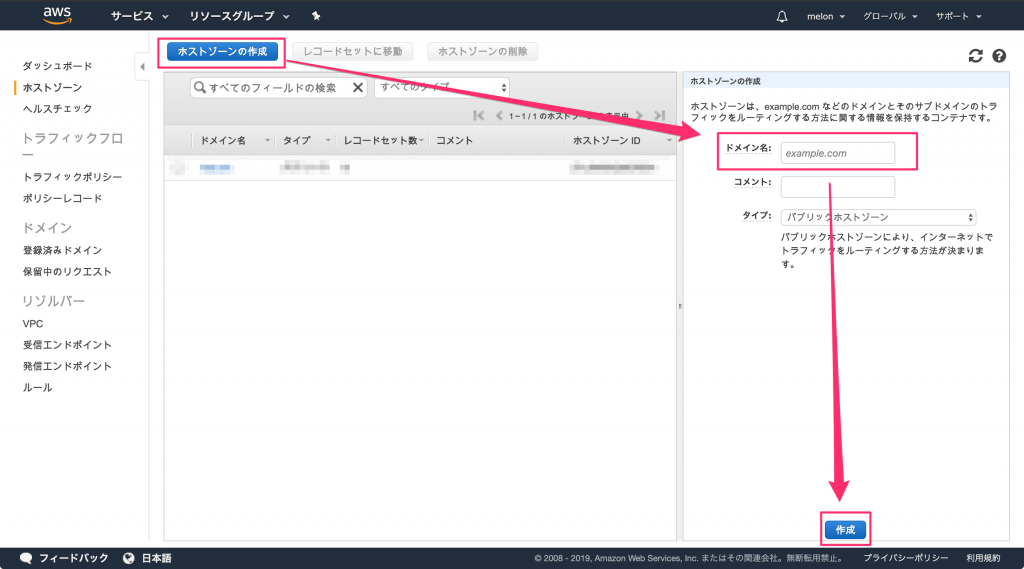

「ホストゾーンを作成」ボタンを押して、どのドメインに関するホストゾーンを作成するかを設定していきます。

「ドメイン名」のところには、お名前.comで取得したドメインを入力します。

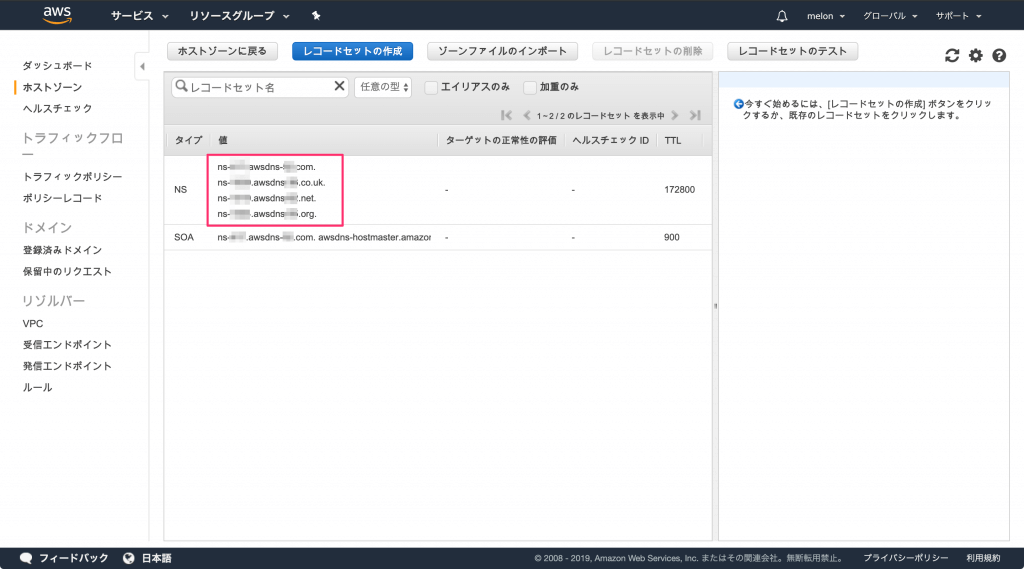

ホストゾーンを作成すると、NSレコードにネームサーバーが4つ割り当てられています。

このネームサーバーの情報はお名前.com側の設定で入力するので内容をメモしておきます。

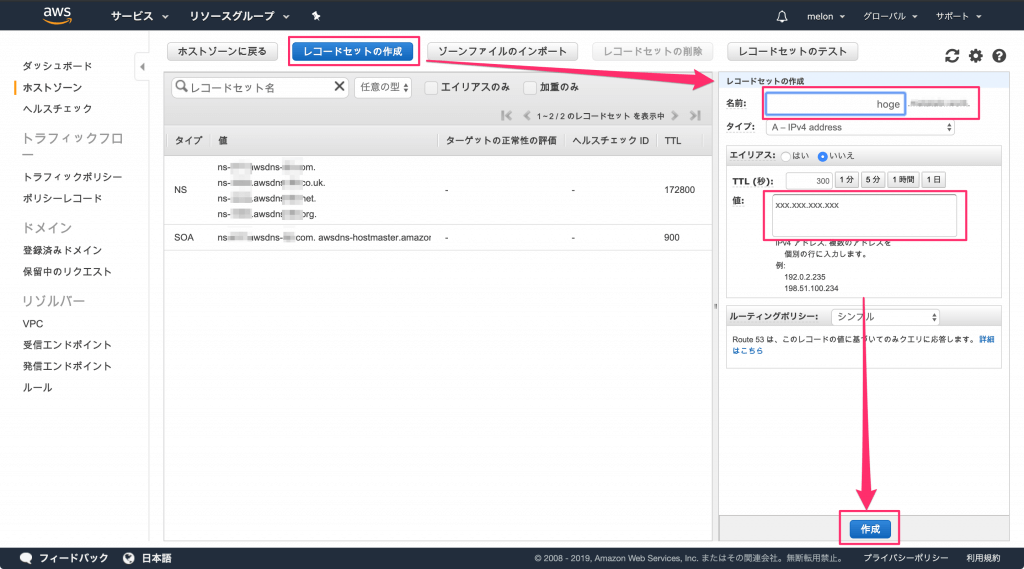

- 作成したホストゾーンにEC2の固定IPアドレスを割り当てる

「レコードセットの作成」ボタンを押して、「名前」に対象のドメイン、値にEC2で割り当てられた固定IPアドレスを入力し「作成」ボタンを押せば完了です。

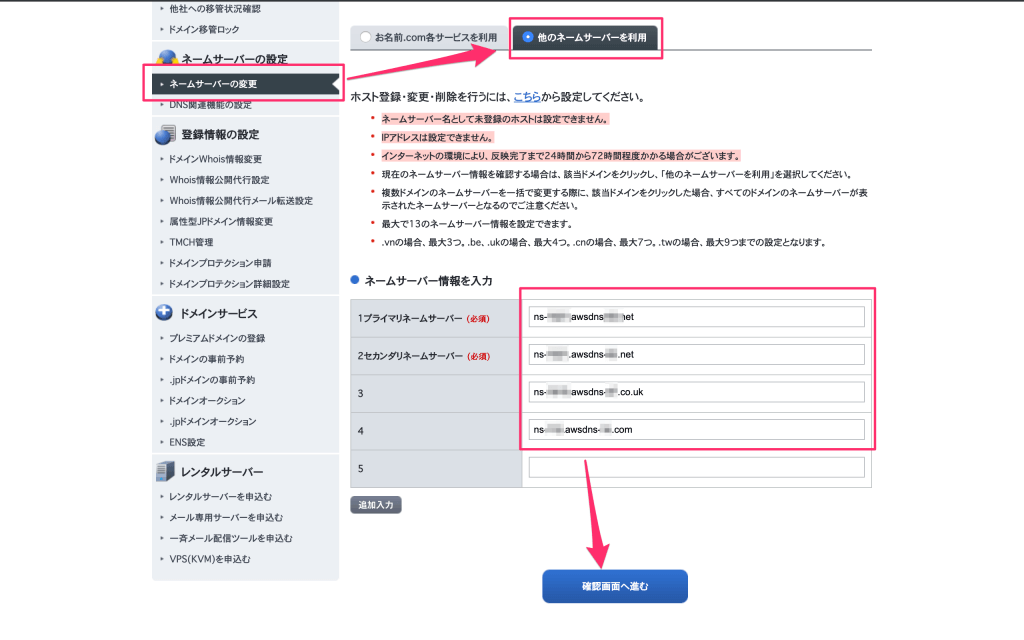

- お名前.comの設定でRoute 53に向けるネームサーバーの設定を行う

ドメインNaviでAWSで利用するドメインの設定を開き、ネームサーバーの変更から「他のネームサーバーを利用」を選択します。

ネームサーバー情報の入力欄に、Route 53のホストゾーンのNSレコードに表示されていたネームサーバーを4つとも入力し登録できれば設定は完了です。

これでお名前.comで取得したドメインにアクセスした際に、AWSのRoute 53で受けることができるようになりました。

- ドメインの動作確認

最後に動作確認をします。

本番環境で下記のコードを入力しましょう。

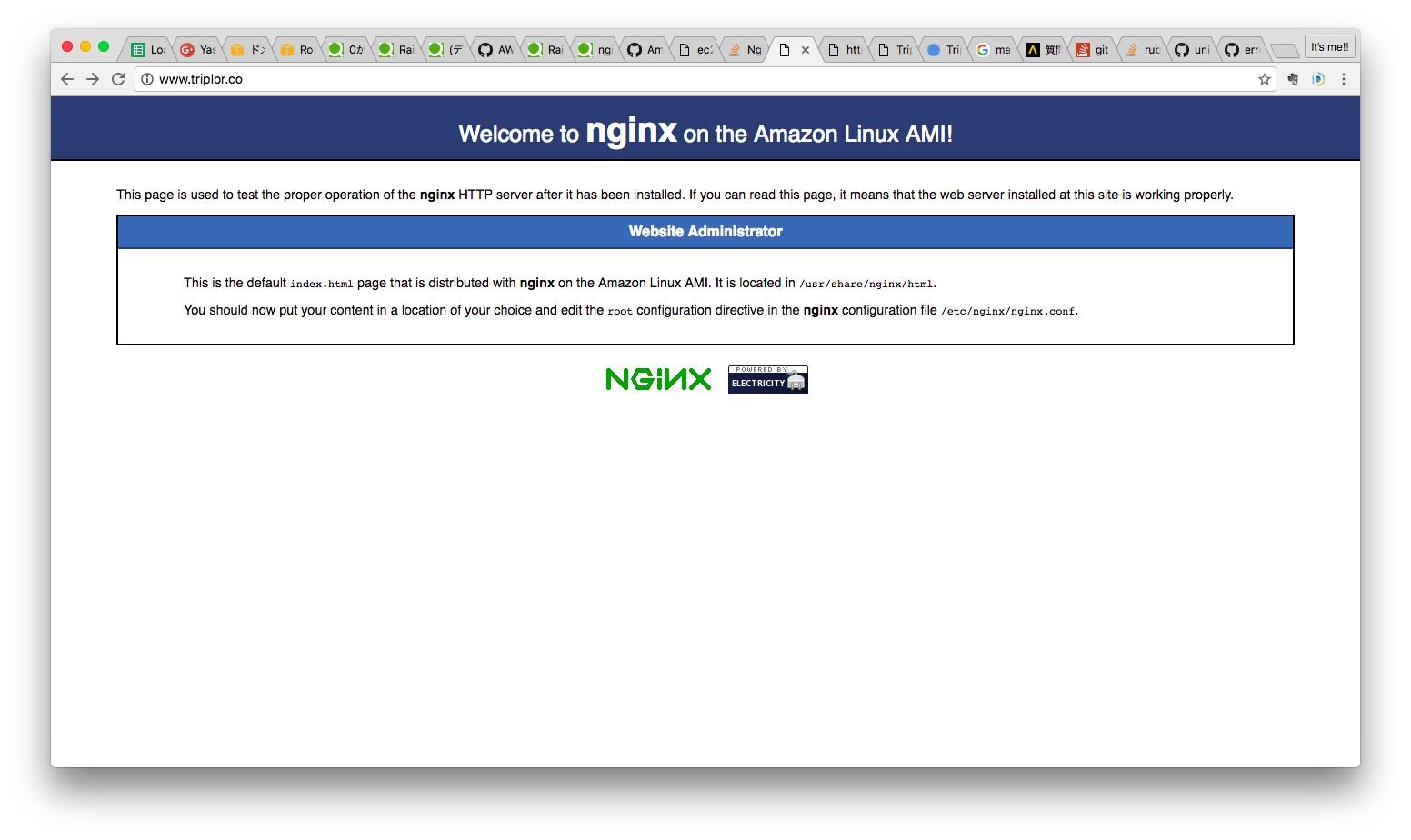

グローバル IP アドレスが返ってくれば名前解決が出来ています。ターミナル(EC2サーバー)[ec2-user@ip-172-31-23-189 <リポジトリ名>]$ nslookup xxxxxxxxxx.com Server: 10.0.0.2 Address: 10.0.0.2#53 Non-authoritative answer: Name: xxxxxxxx.com Address: 54.178.156.248 Name: xxxxxxxx.com Address: 52.197.167.212 [ec2-user@ip-172-31-23-189 <リポジトリ名>]$ブラウザを開き、ドメイン名を入力し、インターネット経由でアクセスできるか確認します。

Welcome to nginx on the Amazon Linux AMI!と表示されていれば成功です。

- nginxの設定ファイルを編集

これではまだ、表示することができないので、nginxの設定ファイルを編集しましょう。

vimコマンドを使ってターミナル上で編集していきます。ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo vim /etc/nginx/conf.d/rails.confrails.confupstream app_server { # sharedの中を参照するよう変更 server unix:/var/www/<アプリケーション名>/shared/tmp/sockets/unicorn.sock; } server { listen 80; server_name <Elastic IPを記入> <ドメイン名>; # クライアントからアップロードされてくるファイルの容量の上限を2ギガに設定。デフォルトは1メガなので大きめにしておく client_max_body_size 2g; # currentの中を参照するよう変更 root /var/www/<アプリケーション名>/current/public; location ^~ /assets/ { gzip_static on; expires max; add_header Cache-Control public; # currentの中を参照するよう変更 root /var/www/<アプリケーション名>/current/public; } try_files $uri/index.html $uri @unicorn; location @unicorn { proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header Host $http_host; proxy_redirect off; proxy_pass http://app_server; } error_page 500 502 503 504 /500.html; }注目すべきは8行目です。

rails.confserver_name <Elastic IPを記入> <ドメイン名>;ドメイン名が追加されていますね!

xxx.comの場合はserver_name <Elastic IPを記入> xxx.com

としましょう。escキーを入力後に:wqで上書き保存を忘れずに!

Elastic IPとドメイン名の間は必ず半角スペースを入力しましょう。

Nginxの設定を変更したら、忘れずに再読込・再起動をしましょう。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo service nginx restartブラウザをリロードし、ドメインで表示できていれば成功です。

できない場合、ブラウザのキャッシュを消去した後、ブラウザをリロードすれば表示できるかと存じます。無料SSL化(Let's Encrypt)

無料のSSLサーバー証明書(以下、SSL証明書)であるLet’s Encryptは、米国の非営利団体であるISRG(Internet Security Research Group)により運営されています。全てのWebサイトを暗号化することを目指したプロジェクトであり、2019年6月現在では世界で1億枚以上の有効な証明書を発行しています。

非営利団体ということで財務基盤に不安を覚える方もいるかもしれませんが、現在ではFacebookやシスコシステムズ、Akamai Technologies、Verizonといった数多くの大手企業に支えられています。

Let’s Encryptでは、90日間有効なDV(Domain Validation)SSL証明書を2つの認証方式(ドメイン認証、DNS認証)で提供しています。SSL証明書は無料で提供されていますが、暗号強度などは一般的に販売されているSSL証明書と違いはありません。

ではレッツゴー!

- certbotをクローン

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ cd /usr/local [ec2-user@ip-172-31-25-189 local]$ sudo git clone https://github.com/certbot/certbot [ec2-user@ip-172-31-25-189 local]$ cd certbot

- 証明書の作成を申請

申請するにあたって、Let's Encryptが認証するためのディレクトリを作成します。

(他の記事では/var/www/htmlなどとしている場合が多いですが、Amazon Linuxではデフォルトでそのようなディレクトリはないので、新たに作成します。)ターミナル(EC2サーバー)# ディレクトリ名は自由ですが、今回は letsencrypt-webroot とします。 [ec2-user@ip-172-31-25-189 ~]$ sudo mkdir /var/www/letsencrypt-webrootさらに、nginxを書き換えます。

rails.conf[ec2-user@ip-172-31-25-189 ~]$ sudo vim /etc/nginx/conf.d/rails.confrails.confupstream app_server { # sharedの中を参照するよう変更 server unix:/var/www/<アプリケーション名>/shared/tmp/sockets/unicorn.sock; } server { listen 80; server_name <Elastic IPを記入> <ドメイン名>; # クライアントからアップロードされてくるファイルの容量の上限を2ギガに設定。デフォルトは1メガなので大きめにしておく client_max_body_size 2g; # currentの中を参照するよう変更 root /var/www/<アプリケーション名>/current/public; location ^~ /assets/ { gzip_static on; expires max; add_header Cache-Control public; # currentの中を参照するよう変更 root /var/www/<アプリケーション名>/current/public; } try_files $uri/index.html $uri @unicorn; location @unicorn { proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header Host $http_host; proxy_redirect off; proxy_pass http://app_server; } # 以下を追加(^~は前方一致です) location ^~ /.well-known/acme-challenge/ { root /var/www/letsencrypt-webroot; } error_page 500 502 503 504 /500.html; }その後、nginxを再起動します。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo service nginx restart次に、以下のコマンドで認証可能かどうかを確認します。

(認証申請が1時間に5回Failすると、一定時間申請できなくなります(Rate Limits - Let's Encrypt - Free SSL/TLS Certificates)。そのため、先に認証可能かどうかを確認します。)ターミナル(EC2サーバー)# 【】の所は置き換えてください [ec2-user@ip-172-31-25-189 ~]$ /usr/local/certbot/certbot-auto certonly --webroot --agree-tos --debug -m 【メールアドレス(例:○○@○○.com)】 -d 【ドメイン名(例:○○.com)】 -w /var/www/letsencrypt-webroot --dry-run以下が出たら認証可能です。

ターミナル(EC2サーバー)IMPORTANT NOTES: - The dry run was successful.上のコマンドの--dry-runを外して認証申請をします。

(登録されたメールアドレスには、Let's Encryptからの通知(認証の有効期限が近づいてきた時の通知など)が届きます。)ターミナル(EC2サーバー)# 【】の所は置き換えてください [ec2-user@ip-172-31-25-189 ~]$ /usr/local/certbot/certbot-auto certonly --webroot --agree-tos --debug -m 【メールアドレス(例:○○@○○.com)】 -d 【ドメイン名(例:○○.com)】 -w /var/www/letsencrypt-webroot以下が出たら認証成功です。

ターミナル(EC2サーバー)IMPORTANT NOTES: - Congratulations! Your certificate and chain have been saved at: /etc/letsencrypt/live/○○.com/fullchain.pem Your key file has been saved at: /etc/letsencrypt/live/○○.com/privkey.pem Your cert will expire on 2019-07-30. To obtain a new or tweaked version of this certificate in the future, simply run certbot-auto again. To non-interactively renew *all* of your certificates, run "certbot-auto renew" - If you like Certbot, please consider supporting our work by: Donating to ISRG / Let's Encrypt: https://letsencrypt.org/donate Donating to EFF: https://eff.org/donate-le証明書が発行されたかを確認します。

ターミナル(EC2サーバー)# 【】の所は置き換えてください [ec2-user@ip-172-31-25-189 ~]$ sudo ls -lrth /etc/letsencrypt/live/【ドメイン名(例:○○.com)】/以下が表示されればOKです。

ターミナル(EC2サーバー)total 4.0K -rw-r--r-- 1 root root 692 May 1 11:41 README lrwxrwxrwx 1 root root 51 May 1 11:41 privkey.pem -> ../../archive/【ドメイン名(例:○○.com)】/privkey1.pem lrwxrwxrwx 1 root root 53 May 1 11:41 fullchain.pem -> ../../archive/【ドメイン名(例:○○.com)】/fullchain1.pem lrwxrwxrwx 1 root root 49 May 1 11:41 chain.pem -> ../../archive/【ドメイン名(例:○○.com)】/chain1.pem lrwxrwxrwx 1 root root 48 May 1 11:41 cert.pem -> ../../archive/【ドメイン名(例:○○.com)】/cert1.pem次に、nginxの設定ファイルをSSL用に更新します。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo vim /etc/nginx/conf.d/rails.confrails.confupstream app_server { # sharedの中を参照するよう変更 server unix:/var/www/<アプリケーション名>/shared/tmp/sockets/unicorn.sock; } server { listen 443 ssl; ssl_certificate /etc/letsencrypt/live/roro-or.com/fullchain.pem; ssl_certificate_key /etc/letsencrypt/live/roro-or.com/privkey.pem; ssl_protocols TLSv1 TLSv1.1 TLSv1.2; # クライアントからアップロードされてくるファイルの容量の上限を2ギガに設定。デフォルトは1メガなので大きめにしておく client_max_body_size 2g; # currentの中を参照するよう変更 root /var/www/<アプリケーション名>/current/public; location ^~ /assets/ { gzip_static on; expires max; add_header Cache-Control public; # currentの中を参照するよう変更 root /var/www/<アプリケーション名>/current/public; } try_files $uri/index.html $uri @unicorn; location @unicorn { proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header Host $http_host; proxy_redirect off; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-Proto $scheme; proxy_pass http://app_server; } error_page 500 502 503 504 /500.html; } server { listen 80; server_name <ドメイン名>; return 301 https://$host$request_uri; }nginxを再起動します。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo service nginx restart設定ファイルの更新はこれで最後になります。あと一息です!

- ポート解放3

私はここで躓きました。

設定ファイルを更新して、「長い戦いが終わった(ニンマリ)」と意気揚々とリロードしたら、タイムアウトで表示されないじゃないか。ふと、

ssl化のポート解放はあるのだろうかと、できているのだろうかと

閃いた。

やはり、ssl化に伴ってポートを開ける必要があるようです。

「セキュリティグループ」のリンクlaunch-wizard-1をクリックします。

「ルールの追加」をクリックします。

タイプを「HTTPS」、プロトコルを「TCP」、ポート範囲を「443」、送信元を「カスタム / 0.0.0.0/0, ::/0」に設定します。「0.0.0.0」や「::/0」は「全てのアクセスを許可する」という意味です。

- rails側の設定

ローカルで下記フォルダの記述を変更しましょう。

config/environments/production.rb(修正前)# config.force_ssl = trueconfig/environments/production.rb(修正後)config.force_ssl = true変更後にmasterへpushしましょう。

ターミナル(ローカル)# アプリケーションのディレクトリで実行する $ bundle exec cap production deploy以上でSSLの設定は完了です。

ブラウザからこのサイトにアクセスしてみましょう。https接続になるはずです。

また、http://として接続した場合でも、自動でhttps接続になるはずです。

- Let's Encryptの自動更新

Let's Encryptの有効期間は3カ月と短いです。

自動で更新されるように、crontabで設定しておきましょう。ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo crontab -u root -e # rootユーザーでcrontabを編集することにより、cronでsudoを使わなくて済むようになります。crontab0 4 1 * * /usr/local/certbot/certbot-auto renew --no-self-upgrade && service nginx restartこの例では、毎月1日午前4時に自動で更新されるようになります。

設定後、cronデーモンを再起動します。

ターミナル(EC2サーバー)[ec2-user@ip-172-31-25-189 ~]$ sudo service crond restart上記の方法では Amazon Linux 2 でエラーが出るようです。

こちらの記事は Amazon Linux の程なのでご了承ください?♂️最後に

最後までお付き合いいただき、ありがとうございました。

twitterやっておりますので是非フォローよろしくお願いいたします!

https://twitter.com/syomabusiness

youtubeも始める予定です!

- 投稿日:2020-04-07T20:12:14+09:00

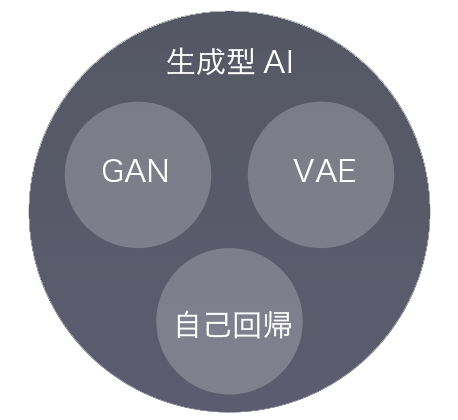

AWS認定クラウドプラクティショナーになろう(超インフラ初心者向け)

おことわり

本記事はクラウドプラクティショナー、つまりAWSの概要を把握しているレベルの知識をキャッチアップできるものになっています。

なので、めちゃくちゃ長いです。

ご注意ください。

また、内容や画像はAWSの公式サイトの物を多く使用しておりますが、中にはキャッチアップのために別のサイトから学んだ内容も入っていると思います。

そちらについては、勉強を実際に行っていたのが1年前のため、判明次第引用として追加させてください。はじめに

皆さん、業務でAWS使ってますか。

AWSを日常的に触る方も、そうでない方もいらっしゃると思いますが、最近以下の記事がトレンドに入っているのを見かけました。

https://qiita.com/aki_number16/items/8ab86ff69200e45cd1bfこれを見て、意外とクラウドプラクティショナーに興味のある方がいらっしゃるんだなと思いまして、クラウドプラクティショナーをとるために学ぶべきことをまとめたものを公開しようと思います。

私も文系エンジニアでインフラ1年目に取得したので、割と0から学ぶにしても網羅できているはずです。対象者

主に、AWS入門者向け、かつインフラ初心者向けの内容となっています。

AWSの概要知識について知りたい方は読むと良いです。

本記事の内容を把握しておけば、クラウドプラクティショナーには合格できます。受験結果

ちなみに、ここまでの知識状態でクラウドプラクティショナー模擬試験を受講したところ、23/25で92%の正答率となりました。

以下内訳です。総合スコア92% Cloud Concepts 80% Security 100% Technology 100% Billing and Pricing 66%この結果不足していると思われた部分については資料内に補足しておきました。

実際の試験ではスコアは891点で、全領域十分な理解をしているとのことだったので、大体本記事くらいの知識を身に付ければ合格できる資格だと思います。良く出た内容としては以下になります。

・サポートプランの差

・EC2 DB ストレージのケース問題(1か月間24時間稼働したい場合EC2のどの運用プランを選ぶかなど)

・ある状況でトラステッドアドバイザーを使うか、クラウドトレイルをつかうか、クラウドウォッチを使うか

・各種設計原則

・TCOについて試験情報

もしクラウドプラクティショナーを受けるようでしたら、以下の動画を参考にするとよいと思います。

https://aws.amazon.com/jp/blogs/news/webinar-bb-practitioner-2018/試験申し込みと模擬試験は下記から行えます。

https://aws.amazon.com/jp/certification/certified-cloud-practitioner/ホワイトペーパーは以下にあり、日本語の物もあります。

著者は本記事の内容を覚えた後、サービス概要だけ読みました。

https://aws.amazon.com/jp/whitepapers/概要

下記のAWSが用意している動画を要約しています。(無料)

資料内で使われる画像も、この動画からキャプチャしたものになります。

https://www.aws.training/transcript/curriculumplayer?transcriptId=yYaEAfD2gEq1JuCJNn7yEw2動画を見て理解できる方なら、この記事より動画を見たほうが、章末問題などがあってよいと思います。

ただ、機械音声とちょっと怪しい日本語が絶妙にストレスになることは覚悟しましょう。

また、動画内に出てきた単語の説明なども行っているので、初学者も理解しやすい内容になっています。

ただし、AWS全般を触っているのでめちゃくちゃ長いです。(私の記事ではいつものことです)読むべき内容は背景を灰色、見出しを赤にしています。

見出しが青の内容は単語の補足です。クラウドの概念

クラウドコンピューティングの定義

量課金制による、インターネット経由の、ITリソースとアプリケーションの、オンデマンド配信サービス「従量課金制」

従量制とは、サービスを利用した時間に応じて料金を課す方式「ITリソース」

システムを構成するハード・ソフトウェアの総称「オンデマンド」

On-Demandとは、英語で「要求(Demand)に応じて」という意味である。

つまり、注文に応じた対応を表す。クラウドコンピューティングができる前

クラウドができる前は、ピーク時にかかる負荷を予想して、キャパシティをプロビジョニングする必要があった。

この場合、予測に満たない負荷の間は使用しないリソースにコストをかけることになり、予測を超えた場合はシステムが耐え切れないという事態になっていた。

また、物理的にマシンを用意する必要があったので、電力や場所など、間接的な費用も掛かっていた。「キャパシティ」

保持、受け入れ、または取り込む能力を言う。

システムの負荷耐性と思えばよい。「プロビジョニング」

準備、用意AWSによって解決された現状

たいして、現在はAWSというITリソースを仮想(物理的に存在しない)の状態で用意できるサービスができた。

AWSのクラウドコンピューティングを使用すると、物理的なITリソースのキャパシティ限界や間接費の問題を解決し、必要な時に必要なだけの高度な機能を使い捨てで使用できるようになった。

これによって今までになかった柔軟性と俊敏性を得ることができた。

例えば、開発者が新しいテスト環境が必要となれば、従来であれば物理的にサーバーを購入するところから始まって、数週間もの時間をかけてプロビジョニングをおこなっていたはずが、AWSを使うことで、数分で環境を立ち上げることも可能となった。

そのため、1つの環境をみんなで初期化したりしながら使いまわして事故が起きたりすることもなく、必要な時に必要な数の環境を用意したりすることができ、より迅速かつ柔軟な開発が行える。クラウドコンピューティングの特徴

システムに伸縮性があることが特徴といえる。

伸縮性はITリソースをスケールアップ(より高い性能にする)やスケールアウト(台数を増やす)を実現できる能力のことである。

必要なマシンの数が1台でも1000台でも、1時間でも24時間でも対応できる。・新しいアプリケーションをすばやくデプロイ(実行可能な状態に)する

・ワークロード(負荷)に応じて瞬時のスケールアップ・アウトが行える

・不要なリソースを即座にシャットダウンできる。

・スケールダウンした分のインフラ料金はかからない

さらに、システムの伸縮性やら柔軟性というだけでなく、高い安全性を実現するのにも非常に有効である。

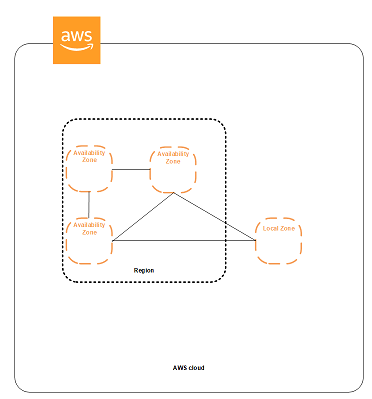

AWSクラウドインフラストラクチャはリージョンとアベイラビリティゾーンを中心として構成される。

アベイラビリティゾーンを分けてアプリケーションやデータベースを管理することで、今までありがちだった単一のデータセンターでは実現できない、高い可用性・耐障害性・拡張性を実現できる。

「リージョン」

世界中にある、AWSのリソースが保管された物理的な場所、2つ以上のアベイラビリティゾーンで構築される「アベイラビリティゾーン」

リージョン内にある1つ以上のデータセンターで構築される拠点

同一リージョンでも、アベイラビリティゾーンが違えばそれらのITリソースは物理的かつ地理的に独立して存在していることを表す。「可用性」

トラブルがあっても、どれだけシステムを動かし続けられるか

加えて、AWSでは多要素認証・アクセスコントロールが導入されており、アカウントの管理を単純なID/PWだけではなく、外部のハードやアプリケーションと連携して安全性を高めている。

つまるところ、便利で安全で簡単ということ。AWSの基本的なインフラについての説明

グローバルインフラストラクチャ

AWSのグローバルインフラは以下の3つの要素で説明できる

- リージョン

- アベイラビリティゾーン

- エッジロケーション

- AWS Local Zones

- AWS Wavelength Zone

- AWS Outposts

https://docs.aws.amazon.com/ja_jp/AWSEC2/latest/UserGuide/using-regions-availability-zones.html「リージョン」

リージョンは世界中にある物理的な場所、2つ以上のアベイラビリティゾーンで構築されるある区域を指す。

リージョンはAWSのあらゆるサービスを配信するデータセンターの所在を区分けしているもので、ユーザーはリージョンとそこに所属するアベイラビリティゾーンを選択し、そこでAWSのサービスを使用する。

AWSサービスやストレージ(データの保存場所)等は、リージョン別に存在しているものもあるため、どのリージョンを選ぶかという話がまず存在する。

このときに重要なのは、対象リージョンに自分の使用したいサービスが存在するかと、レイテンシー(遅延)がどの程度発生するかである。

レイテンシーについては単純に自分の端末から地理的に近いリージョンを選択すれば問題ない。

サービスについては公式サイトを確認するのが良い。

https://aws.amazon.com/jp/about-aws/global-infrastructure/regional-product-services/リージョンは地理的に離れて存在するため、システムの可用性を高めるためにマルチリージョン(複数のリージョン)に同じ構成のシステムを構築するということも検討できる。

例えば日本に地震が起きてデータセンターがすべて機能しなくなっても、アメリカに構築したシステムには影響がないからだ。「アベイラビリティゾーン」

アベイラビリティゾーンはリージョン内にある1つ以上のデータセンターである。

(複数のデータセンターをまたいで構築されることもあるので、単一のデータセンターというわけではない。)

例えば、日本リージョンに存在する東京AZと京都AZといったように想像すればわかりやすい。

此方も地理的に離れており、AZ同士は電力元も含めてあらゆるリソースを独立して持っているため、システムの可用性を高めるために同じ構成のシステムを構築することも検討できる。

マルチリージョンまでしなくとも、マルチアベイラビリティゾーンにはしておくということが多い。

AWSはマルチAZでデータをプロビジョニングすることをベストプラクティスとしている。

AZ間は高速かつ低レイテンシー(遅延)で接続されている。「エッジロケーション」

アベイラビリティゾーンとは別で立っている小さなデータセンター。

エッジロケーションではAmazon CloudFrontというコンテンツ配信ネットワーク(CDN)が提供される。

CloudFronとはコンテンツへのリクエストがあった際、最もユーザーに近いエッジロケーションからコンテンツを配信するサービスで、エンドユーザーに対して素早くコンテンツを配信できる。

また、ElastiCacheというキャッシングを行うサービスにも使われる。「AWS Local Zones」

コンピューティング、ストレージ、データベース、およびその他の選択された AWS のサービスを、エンドユーザーから近い場所に配置できる、アベイラビリティゾーンのさらに細かいものです。

地理的にエンドユーザーと近い場所で、レイテンシーの影響を受けやすいアプリケーションを実行できます。「AWS Wavelength Zone」

モバイルデバイスおよびエンドユーザーに対して 10 ミリ秒未満のレイテンシーを実現するアプリケーションを、開発者が構築できるようになります。

AWS 開発者は、Wavelength Zone にアプリケーションを配置することができます。

AWS Wavelength により、AWS のサービスを 5G ネットワークのエッジで提供できるため、モバイルデバイスからアプリケーションに接続する際のレイテンシーを最小限に抑えることができます。アプリケーショントラフィックは、モバイルプロバイダーネットワークから出ることなく、Wavelength Zone で実行されるアプリケーションサーバーに到達できます。これにより、インターネットまでの間にある、100 ミリ秒以上のレイテンシーを引き起こし得る余分なネットワークホップ数が削減されるため、お客様は、5G の広い帯域幅と低いレイテンシーを使い切らずにすみます。

対モバイルで高速な動作が要求されるときに使用します。「AWS Outposts」

AWS Outposts は、オンプレミス(物理的にPCを用意してそこで動作する)のシステム、ローカルのデータ処理、またはローカルのデータストレージへの低レイテンシーのアクセスを必要とするワークロードに最適です。

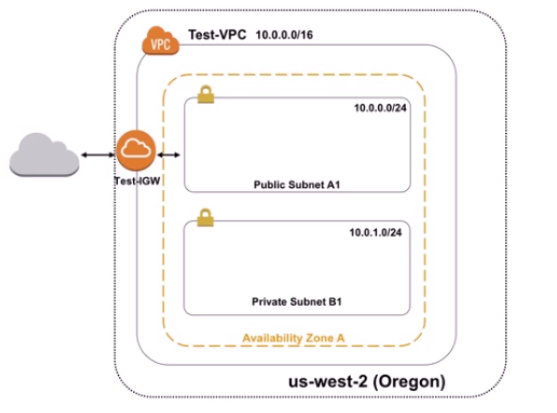

要約すると、AWS上ではなくオンプレミス上で動作するシステムがAWSと高速に連携できるようになるものです。ネットワーク(Amazon Virtual Private Cloud VPC)

AWSはクラウドコンピューティングサービスであり、それらが提供するITリソースは仮想のものである。

そのため、ネットワークも自社のものではなく、外部に作ることになるわけだが、その時によりセキュアなネットワークでITリソースを管理したいなどの欲求がある。

そこで使用するのがこのVPCというサービスである。

VPCは、AWSクラウド内にプライベートなネットワークを構築することができる。

このネットワークは、構築するうえで様々な項目を設定可能としており、

使用するIPアドレスの範囲やサブネット、ルートテーブルといった標準的なネットワークの構成項目を定義できる。

こうすることで、インターネット上に公開するものや、アクセス制限をかけるものを分けて管理することができるようになる。「サブネット」

文字通り、VPCの大きなネットワークの中をさらに区切るサブのネットワーク「ルートテーブル」

ルートテーブルとは通信をどこに流すかを定義するための情報で、サブネット毎に存在する

例えばVPCネットワークAに所属するサブネットAに紐づいているルートテーブルに送信先は10.0.0.0/16のIPアドレスの範囲にのみ通信を許可すると書かれていたとすると、サブネットAに所属するサーバーからは10.0.0.0/16の範囲にしか通信を行えなくなったりする。VPCを使う上での注意点

VPC内にサーバーを立てたりすると、同時にそのサーバーに住所が割り振られる。

この住所がIPアドレスである。

ネットワーク内での通信はこの住所を指定して行う。

このIPアドレスのどこからどこまでを使用するかという定義は、複数のVPCを使用する場合には意味を持つ。

VPCピアリングというサービスをつかって複数のネットワーク(VPC)をまたいで通信を行う場合、IPアドレスの範囲がかぶっていると、ネットワークAのIPアドレスかネットワークBのIPアドレスかを特定することができない。

そのため、複数のVPCネットワークを使用する場合、そのIPアドレスの使用範囲がかぶらないようにネットワークを構築する必要がある。また、VPCはAWSの基幹部分ともいえるサービスで、VPC内で使用できるAWSは非常に多い。

例えば、サーバーを立てるEC2などが代表される。VPCはリージョン単位で使用するもので、アベイラビリティゾーンごとにVPCを用意することができない。

そのため、リージョンにVPCを建て、その中にアベイラビリティゾーンを分割してサブネットをいくつか作り、そこにサーバーを立てたりするような使い方になる。サブネットは、複雑化を避けるためなるべく少数にとどめることが推奨される。

デフォルトではVPC内のすべての場所に通信を許可するため、プライベートかパブリックか等も含めてサブネットを差別化したい場合は、ルートテーブルの編集を忘れないこと。「パブリックネットワーク」

インターネットにアクセスできるネットワーク

VPCにインターネットゲートウェイをアタッチし、VPC内以外の通信トラフィック(ネットワークを流れる情報)をインターネットゲートウェイに送信するようにルートテーブルを設定した場合、実現することができる。

また、VPC内のインスタンスがパブリックな通信を行おうとした場合、パブリックIP(インターネットに公開されるIP)が必要になる。「インターネットゲートウェイ IGW」

インターネットにアクセスするための通信の出入り口「プライベートネットワーク」

インターネットにアクセスできず、特定の範囲でのみ通信を許可されたネットワークコンピューティングサービス(EC2・Lightsail・ECS...)

どのようなサービスを立ち上げるにしろ、サーバーレスで実装することを除けば、まずはコンピューターを用意してサーバーを立てるところから始まる。

サーバーを物理的に用意するオンプレミス環境では、物理的にPCを購入し、保守人員を確保し、物理的な環境を整え、定期的にメンテナンスを行うと多額のコストがかかる。

また、PCは利用状況ではなくプロジェクトの計画によってスペックが決定されるため、運用や計画が後に変わった場合に対応することも難しい。「オンプレミス」

自社内の設備によって運用することを指します。

会社でコンピュータを買ってきて、設置して、そこで動くシステムをオンプレミスで稼働するシステムと呼びます。

しかし、AWSにおいては使うときだけ仮想上に指定したスペックでサーバーを起動できるため、スケールアップもスケールアウトも思いのままだ。

物理的なサーバーを管理する必要がないので、物理的な環境も必要がなく、早い話がクライアントPC1台を用意してAWSが提供するサービスを使うだけでよいのだ。「スケールアップ・スケールアウト」

スケールアップはサーバーを増強すること、スペックを上げることを言います。

スケールアウトはサーバーの台数を増やすことを言います。

どちらもサーバーにかかる負荷が大きくなったときに行う対応です。代表的なのは

Amazon Elastic Compute Cloud(EC2)で、安全でサイズ変更可能なコンピューティング性能をクラウド内で提供してくれる。

EC2を使うことによって、プロジェクトの計画による事前のプロビジョニングではなく、現状・必要にあわせたサーバーを使用することができる。

他にも、AWSはAmazon Lightsailというサービスを提供している。

これは、数分で仮想プライベートサーバーを起動して、ウェブサーバーとアプリケーションサーバーを管理できるようにしてくれる。他にも、AWSは

Amazon Lightsailというサービスを提供している。

これは、数分で仮想プライベートサーバーを起動して、ウェブサーバーとアプリケーションサーバーを管理できるようにしてくれる。また、Dockerコンテナ(仮想環境の一種)を使用している場合にも、

Amazon Elastic Container Service(ECS)が対応している。

このサービスは、インフラストラクチャの部分もまるごと管理してくれるため、ユーザー独自で運用システムを用意する必要がなくなる。さらに、

AWS Lambdaというコード実行サービスを使えば、そもそもサーバーを建てる必要もなく、ただコード実行のみ行うこともできる。

もはやサーバーを起動したりすることを考える必要すらない、サーバーレスを実現できる。

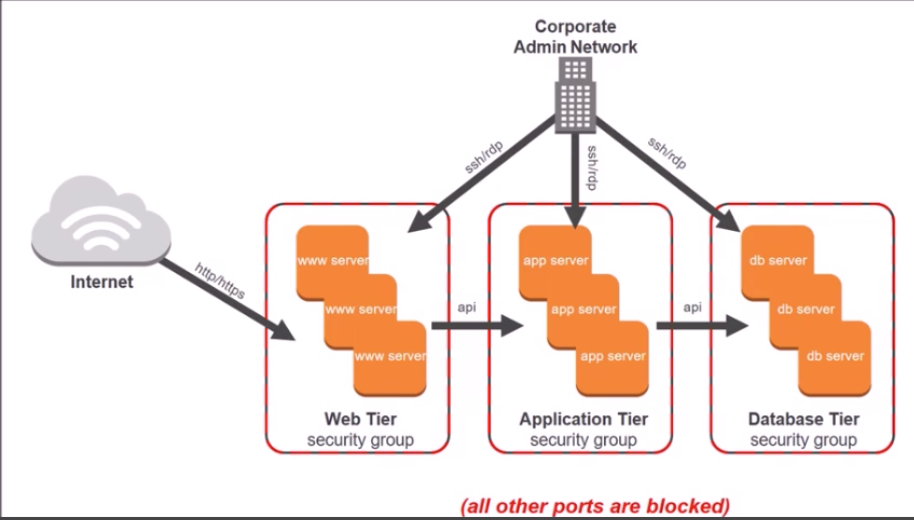

これもまた、物理的なリソースを必要としないクラウドだからこそ実現できるメリットであるといえる。セキュリティグループ

セキュリティグループは仮想サーバーにおけるファイアーウォール(通信制限をかける機構)といえる。

セキュリティグループを詳細に設定することで、自分が構築したサーバーへのアクセスをコントロールすることができる。例えば、以下ではDBServerにアクセスできるのはAdminNetworkを除けばAPPServerだけである。

WWWServerからアクセスすることはできない。

そういったコントロールを行うのがセキュリティグループ(SG)である(多層ウェブアーキテクチャを前提とした多層セキュリティグループの例)

「多層ウェブアーキテクチャ」

アプリケーションを複数のソフトウェアエージェントで実行するクライアントサーバーモデル。

代表的なモデルとして三層アーキテクチャがある。

三層アーキテクチャはユーザインタフェース・ビジネスロジック・データベースでアプリケーションを分割して稼働させるもであるである。「クライアント・サーバーモデル」

昔はメインフレームと呼ばれる一台の巨大なPCを操作していたが、現在はPCの価格低下により複数台のPCをそれぞれ役割に特化させて組み合わせて使うようになった。

こうして、操作するPC(クライアント)と提供するPC(サーバ)に分けた運用が一般的となり、これをクライアントサーバーモデルと呼ぶ

基本的にサービス提供を行う側がサーバーを用意し、ユーザーは自分の持つ端末をクライアントにすることが多い。(例:google検索)上の図を読み解いていくと、まずウェブアプリケーション層(ユーザーインターフェース)がインターネットからの接続を受け付けているため、SGによって送信元0.0.0.0/0(デフォルト設定)ですべての接続を受け付ける状態であることがわかる。

ちなみに、ルートテーブルとの違いは、ネットワーク全体の設定であるか、SGに所属するサーバーの設定であるかである。

その後、アプリケーション層(ビジネスロジック)ではウェブアプリケーション層からのアクセスだけを受け付け、データベース層はアプリケーション層からのアクセスのみを受け付けることがわかる。このような細かいアクセスの設定を行えるのが、SGである。

主要なサービスの紹介

全てを紹介することはさすがに難しいのですが、よく使われる主要なサービスを紹介します。

クラウドプラクティショナー試験の選択肢に出てきたものは全て載せるようにしています。Amazon Elastic Compute Cloud EC2

よくEC2と呼ばれるが、Amazon Elastic Compute Cloudの略で、サーバーを立てるときに使う。

AWSではサーバーのことをインスタンスと呼ぶので、今後インスタンスを記載されたらEC2によって建てられたサーバーのことだと覚えておく

仮想のサーバーなので、AMIという形でバックアップを取っておけるし、AMIを共有することで誰でも決まった構成のインスタンスを立てることもできる。ec2インスタンスは、用途に合わせて様々な種類を要している。

例えば、データベースサーバーにするなら物理メモリ容量を最適化したいが、そういった場合はr4シリーズのインスタンスを使うなどである。

これによって、ユーザーは様々な役割に合わせて最適なサーバーをプロビジョニングできるようになる。さらに、インスタンスの運用方式にもいくつかの種類がある。

これには3種類の実行方式がある。「オンデマンド」

リクエストに応じてインスタンスを起動する。

通常はこの形態で、必要な時にインスタンスを起動し、不要な時に止める。「リザーブド」

事前に1年もしくは3年の単位で料金を払っておくことで、通常より安い金額でインスタンスを起動できる。

長期的かつあるていど安定した運用を行えるものはこの方式にすることでコストを抑えられる「スポット」

インスタンスの料金が常に変動し、一定金額以下の場合に起動、高くなったら停止という運用方式。

作業を中断したり、1日のうちどこかで作業を行えればよいものなどはこれを使うことでコストを安く抑えられる。AWS Lambda

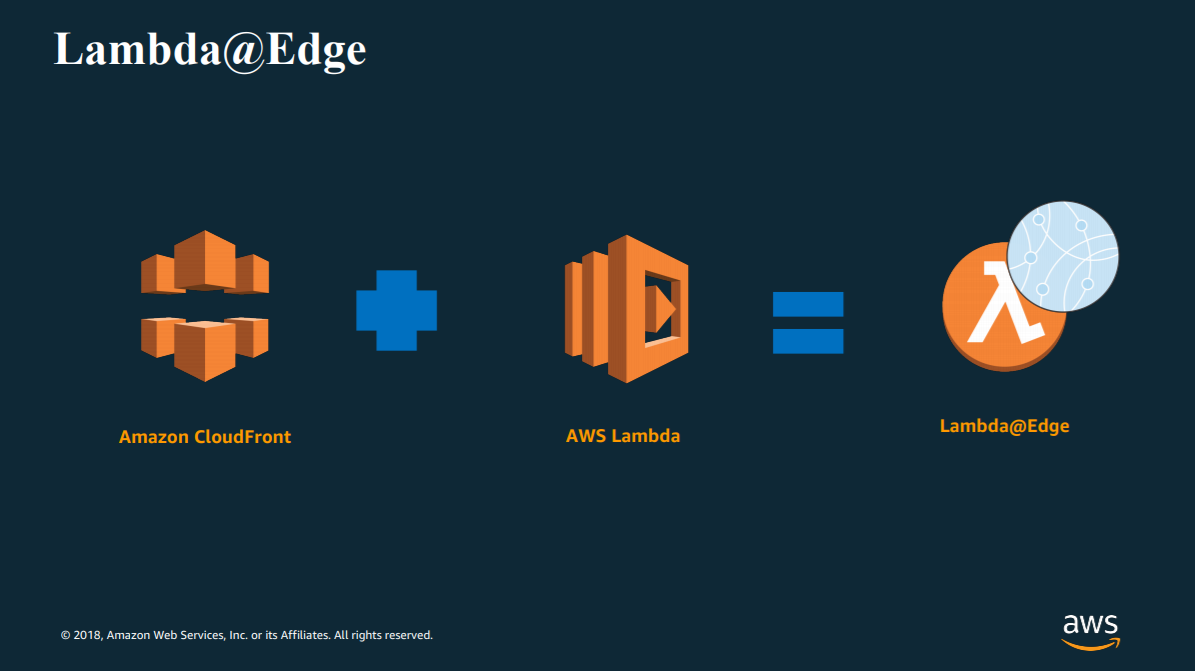

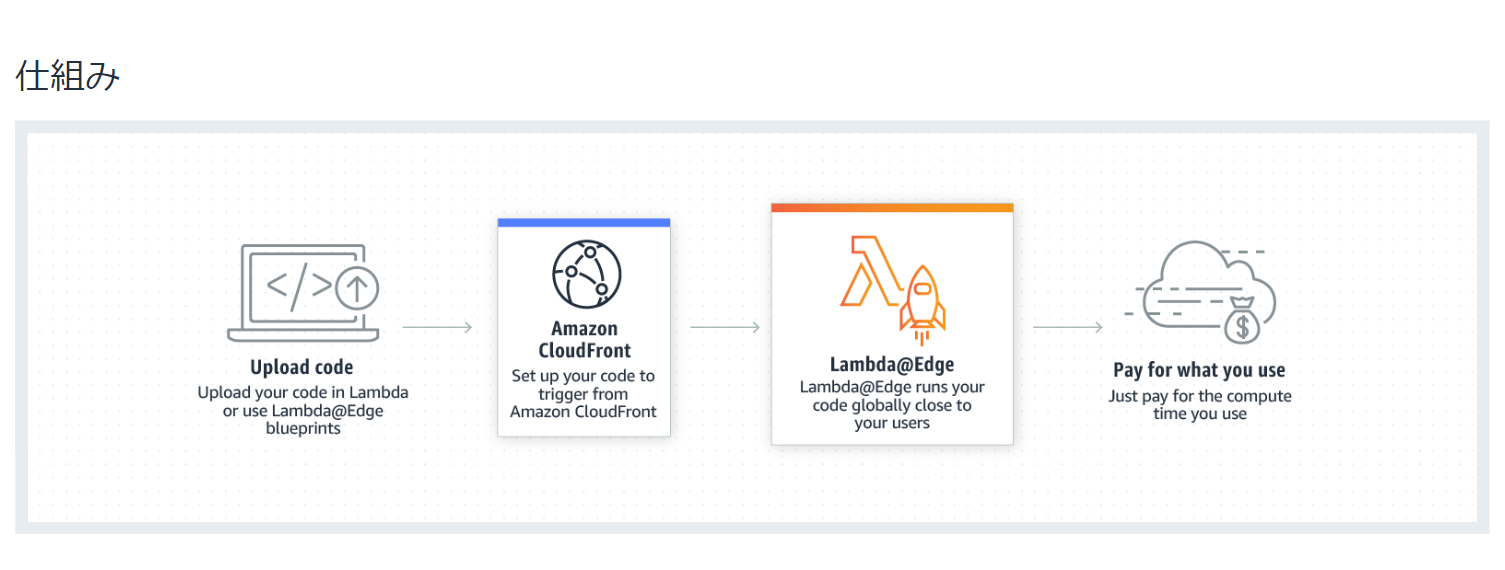

以前説明したように、AWS Lambdaはサーバーレスでコードを実行することができるイベントドリブン型のサーバーレスコンピューティングサービスである。

AWSでは、様々なサービスが動作をしており、これらがどのように実行されたかをイベントとしてキャッチしてコードを実行することができる。「イベントドリブン」」

event driven 何かイベントが発生して、それに対応してプログラムが動くこと

イベント駆動ともいわれる。

AWS Lambdaでは、サービスのプロビジョニングを行わずにコードを実行できるので、サーバーを管理する必要がない。

これをサーバーレスという。

AWS Lambdaでは可用性の高いコンピューティングインフラストラクチャでコードが実行されており、ログをとったりコードをモニタリングしたりと、あらゆる管理を行える。

また。サポートされている言語もNode.js Java C# pythonなど幅広い。

また、AWSのイベントだけでなく、Amazon API Gatewayを使用したhttpリクエストへの応答などでも起動することが可能である。

また、実行されるコード自体についても、Amazon CodePipelineやAWS CodeDeployを使用して自動的にデプロイすることもできる。スペックとしては以下のようになる。

・ディスクスペース 512MBまで

・メモリ 128~1536MBまで

・実行時間 最大5分まで

・リクエストとレスポンスのペイロード 6MBまで

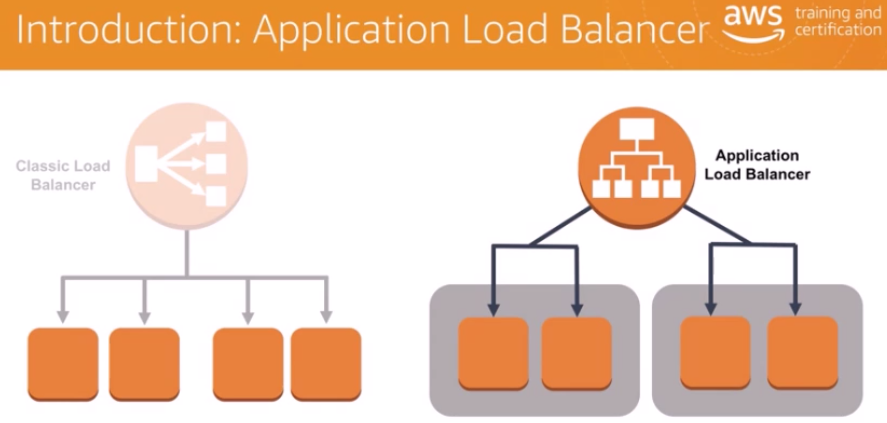

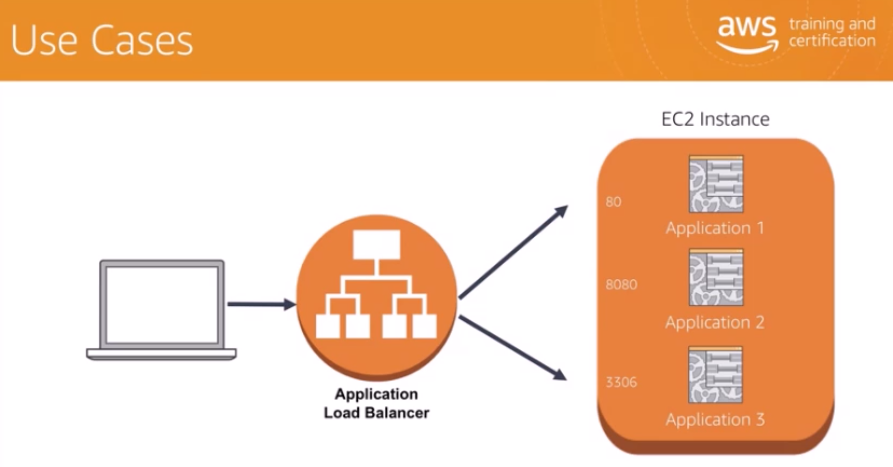

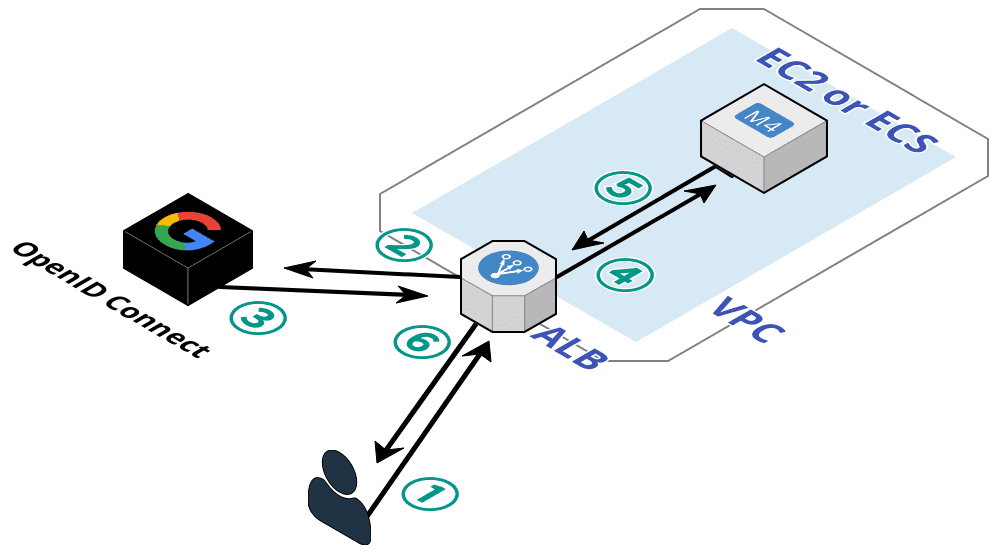

・イベントリクエストの本文 128kbitまでElastic Load Balancing(ELB) Application Load Balancer(ALB)

ALBはELB(Elastic Load Balancing)のサービスの一部として導入された2種類目のロードバランサー

CLB(Classic Load Balancer)の後継機で、これにいくつかの機能を追加した強化版「ロードバランシング」

複数のサーバ、コンピュータ機器に対してリクエストや処理などを振り分けること例えば同じ内容のアプリケーションをデプロイしたサーバーインスタンスを複数用意し、これらにアクセスを分散させて負荷分散を実現したいときなどに、ALBはそれらを適切に行ってくれます。

ALBでは様々なリクエストを受け付ける中で、どのような通信ポート番号でアクセスしてくるかによって、アクセス先のpathを差別化することもできます。「path」

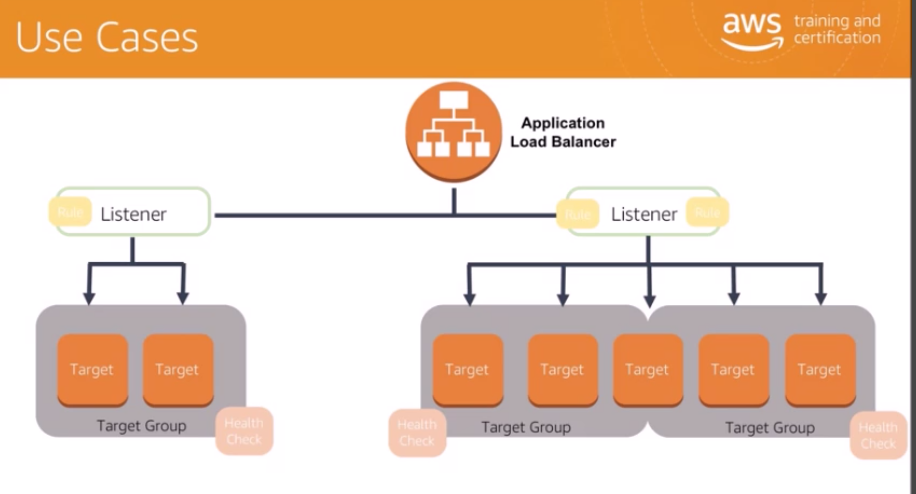

ファイルまでの階層 C:\Users\works\Desktop....みたいなALBを知る上で、以下の3つの要素について知っておきましょう。

「Listener」

リスナーは接続要求をチェックするプロセスです。

設定したプロトコルとポートを使用します。

リスナーに対して定義したルールによって、ロードバランサーが1つ以上のターゲットグループ内のターゲットに要求をルーティングする方法が決まります。「Target」

ターゲットは、確立されたリスナールールに基づくトラフィックの宛先です。

「Target Group」

各ターゲットグループは、指定された通信プロトコルとポート番号を使用して、要求を1つ以上の登録済みターゲットにルーティングします。

ターゲットは複数のターゲットグループに登録できます。 ヘルスチェックは、ターゲットグループごとに設定できます。「ポート」

通信機器や個々のコンピュータの持つIPアドレスの下に設けられた補助アドレスとして、0から65535までの「ポート番号」が使われる。

これにより、1台のコンピュータで複数のサービスを提供したり、複数のコンピュータと同時に通信できるようになっている。

例えば、同じサーバーにアクセスするのでも、ポート1001番はテスト環境、ポート1000番は本番環境というように分けることができる。

例 http://172.255.255.255:10001/ ここでいう:の左側がIPアドレスで、どのサーバーにつなぐかを表しており、:より右側がポート番号「通信プロトコル」

プログラムの通信方式

SSHやTCP等といった種類があるが、主に相互に通信を送受信するために、お互いが同じ方式でデータを解釈できるようにきめたフォーマット、ルール。

「日本語で話す」プロトコルを自分と相手で共有が取れてないと、例えばアメリカ人に日本語で話しかけてもいい返事は帰ってこない。

多分エラーメッセージ「ぱーどぅん?」が返ってくる。ネットワーク接続は、前述したIPアドレス・ポート・通信プロトコルを組み合わせて行われるということがわかればよい。

AutoScaling

オートスケーリングは非常に便利な機能です。

ロードバランサーの話がありましたが、オートスケーリングは負荷に合わせて自動でインスタンスの数を増やし、ロードバランサーが自動でそのインスタンスにアクセスを割り振ってくれます。

もちろん、その逆も可能です。オートスケーリングでは、起動設定・Auto Scaling グループ・Auto Scaling ポリシーを登録する必要があります。

グループでは、いくつ以上いくつ以下のインスタンス数を保つか、どのロードバランサーで管理するかなどの情報を設定します。

ポリシーはスケールを行うスケジュール登録です。

負荷分散だけでなく、サービスを自動的に停止・開始するという使い方もできます。Amazon Elastic Block Store EBS

EBSはEC2でつかえるストレージです。

これはドライブをHDDにするかSSDするかなども選べ、容量が不足したら簡単に追加することができます。

これらは使用した分だけ料金がかかります。「ストレージ」

ファイル置き場、倉庫、保管ボックスみたいなイメージ「HDD」

HDDはHard Disk Drive(ハードディスクドライブ)の略で、データやプログラムなどを電磁的に書き込んだり読み出したりする記憶装置です。

SSDと較べて1ドライブで保存できるデータ量が大きい

「容量単価」としては安価になる

消費電力が比較的大きい「SSD」

SSDはSolid State Drive(ソリッドステートドライブ)の略で、HDDと同様の記憶装置です。

半導体素子メモリを使ったドライブ(記憶媒体)のことを指します。

読み書きの速度が非常に速い

容量が少ない

まだまだ容量単価としての価格は高い物理的に存在しているストレージ(皆さんのPCの中にあるHDDなど)と比較し、EBSは物理的な故障もなくレプリケーションもできるため耐久性が高く、カスタマイズも自由です。

ログ置き場は速度がいらない安価なHDD、アクセスを繰り返す部分には高速なSSDなど運用も効率的に行えます。

データはスナップショット(ある時点のバックアップ)を作成でき、リージョンをまたいで移動することもできます。

容量が足りなくなれば、あとから簡単に拡張することもできます。「レプリケーション」

データを別のところで同じように複製する。EBSの種類は、大きく5つ。SSD2種類、HDD2種類、旧世代のマグネティック1種類、となっています。

SSDとHDDの比較としては、IOPS(インプット・アウトプット Per Second、1秒あたりの処理できるデータの出し入れの数)とスループット、コストがよく用いられます。あとそれらを考慮した上での具体的な使い分け、とか。

ざっくりまとめると、SSDは「高IOPS」「ランダムアクセス向き」、HDDは「高スループット(処理能力)」「シーケンシャルアクセス(記憶媒体の先頭から順に検索しアクセスしていく)」「低コスト」、という感じ。

マグネティックはコストを下げたければというところです。

あと、HDDは起動ボリュームに指定できません。

SSD、HDDともに、それぞれ汎用・高性能が選択できます。EBSの特徴

•AZごとに独立、他のAZのEC2からは使用不可

•スナップショットをS3に保存可能、S3経由で他AZに移動可能

•EC2とEBSは1:Nの関係で構築できるAmazon simple Store service S3

こちらもストレージサービスです。

EBSがインスタンスのストレージとなるもので、インスタンスごとに別にで用意されるストレージなら、こちらはインスタンスに関係なくどんと用意されているストレージです。

グローバルサービスといって、同一リージョン内のリソースが共通で使用することができます。

様々な場所から共通でアクセスできる保存ボックスです。EBSは容量の制限があり、その使用料から料金が決められていました。

S3は数テラバイトあろうがすべて保存できます。

それゆえ、料金はリクエスト単位となっています。

PUT COPY POST LIST GETはすべてお金がかかります。

また、データはHTTPアクセスできるためすべてURLが自動で付与されますし、低レイテンシーです。

プライベートなネットワークからでもアクセスできます。

S3はバケットという単位で内部を区切ることができ、バケット別にアクセスをコントロールしたりもできます。Amazon Glacier

ぐれいしあって読みます。これもストレージです。

S3より遅いけど安いやつで、法律上必要だけど普段まったくアクセスしないみたいなファイルを長期間保存することにむいています。

グレイシアは遅いので、データの取り出しには数分から数時間かかります。ここに保存されるデータは「アーカイブ」という単位で保管されます。

また、S3でいうバケットにあたる、保管場所のことを「ボールド」と呼んでいます。

グレイシアでは、S3などのアクセス可能なあらゆる場所のデータをアーカイブできます。

例えば、S3に保存された30日以上アクセスのないデータはグレイシアに自動的に移動するといったことも可能です。

S3は最大5TBのファイルを保存できますが、グレイシアは40TBものファイルを保存できます。

これはどちらも1ファイル当たりの最大容量で、ストレージ自体の容量限界はありません。

料金はアップロードと取り出し時にかかります。Amazon Storage Gateway

オンプレ環境とAWS環境の間でシームレスに使えるストレージ

Amazon Command Line Interface CLI

AWSのアカウントを作成すると、ブラウザ上でマネジメントコンソールを開いてそのうえでリソースを操作します。

CLIはブラウザではなくコマンドプロンプトやターミナルからコマンドでawsを操作できる機能です。

スクリプト化すればawsへの操作を自動化することもできます。

例えば、pythonのboto3モジュールなどを使ってAWSのAPIを実行することで、AWSを画面から操作しなくてもインスタンスの情報を取ったりできます。Amazon Relational Database Service RDS

これはアマゾンが提供するリレーショナルデータベースです。

リレーショナルデータベースというのは、表でデータを管理していて、SQLを使って高度なデータの検索が行えたり、トランザクションの管理ができたりするデータベースです。

例としてはOracleやDB2などがあります。

対して、KVSという、キーと値だけでデータを持っているデータベースもあります。

RDBは複雑な条件を指定した検索に向いており、KVSは速度を重視する場合に使用します。

業務用のアプリケーションでは、ほとんどがRDBを使用しています。通常、データベースとはデータが追加でどんどん入ってきて容量が大きくなったり、頻繁にアクセスされたりするものなので、スケールやらセキュリティやらパッチ適用やら、そもそもインストールやらとたくさんの管理タスクが存在します。

内容も単純でなく、専門的な知識を必要とするものが多いです。

RDSではそれらを大幅に自動化しています。

パッチ適用やバックアップ、スケーリングやらの管理タスクも自動になるのです。

また、データの内容をコピーし、スタンバイ状態で別のアベイラビリティゾーンにデータベースインスタンスを立てておくこともできます。

これによってデータベースインスタンスのあるアベイラビリティゾーン単位で障害が起きた場合でも、迅速な復旧を行えます。RDSでは6種類のリレーショナルデータベースに対応しており、ユーザーのニーズに応じて選ぶことができます。

Amazon Aurora

RDSは様々なリレーショナルデータベースを提供するサービスでした。

Auroraは、RDSで提供されるリレーショナルデータベースのうちの一つです。

Amazon Aurora は、標準的な MySQL データベースと比べて最大で 5 倍、標準的な PostgreSQL データベースと比べて最大で 3 倍高速です。

また、商用データベースと同等のセキュリティ、可用性、信頼性を、10 分の 1 のコストで実現します。

Amazon Aurora のストレージシステムは分散型で耐障害性と自己修復機能を備えており、データベースインスタンスごとに最大 64 TB まで自動スケールされます。

Amazon Aurora は、最大 15 個の低レイテンシーリードレプリカ、ポイントインタイムリカバリ、Amazon S3 への継続的なバックアップ、3 つのアベイラビリティーゾーン (AZ) 間でのレプリケーションにより、優れたパフォーマンスと可用性を発揮します。つまり、一般的なリレーショナルデータベースよりも早くて安い上で安全安定性は一般的な水準を出せ、単一障害点(ここが壊れたらシステムが止まる)となりやすいデータベースの弱点を分散型にすることで補っており、自己修復もスケールもできてリカバリーもできるすごいデータベースですよということです。

Auroraは高性能なDBですが、今まで使っていたアプリケーションをクラウドに移行するという場合、データベースは既存のものを使用しているはずです。

この置き換えを行うか否かという判断は、Auroraの可用性にあるといえます。当然ですが、たいていの場合はデータベースは一つで、その中にデータを入れています。

その場合、対象のデータベースは単一障害点となります。

これは、データベースがトラブルにあった場合、システムは止まってしまうということです。

Amazon Auroraでは、高可用性を実現できます。

Auroraでは継続的にS3にバックアップを作成しながら、3つのアベイラビリティゾーンにデータのコピーを6つ保存します。

また、データベースはマスター(更新対象)とリードレプリカ(参照対象)にわけて管理され、リードレプリカは15個まで用意できるため、データの損失が発生することはありません。

さらに、Auroraはプライマリーデータベース(データベースが作成され、メンテナンスされる本番データベース)がクラッシュした場合、60秒以内に復帰できるように設計されています。

これは、通常であればREDOログというデータベースに対して行われた更新ログからすべてのSQLを実行しなおして復旧するところを、データベースへの読み込み動作があるたびに細かく行って状態を保存しているためです。これらの耐障害性能がどうしても欲しいなら、データベースのリプレイスは十分検討されるべきでしょう。

Amazon DynamoDB

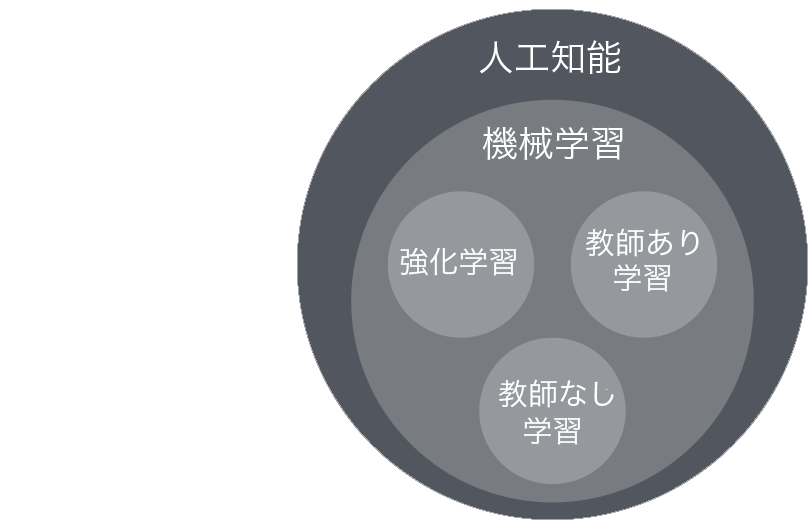

DynamoDBは、NoSQLのデータベースです。

リレーショナルデータベースのようなSQLを使って複雑にデータの検索を行えるデータベースに対して、高い速度が評価できます。

また、リレーショナルデータベースではテーブル(データを入れておく場所)の構造を更新する場合はすべてのデータを更新する必要がありますが、NoSQLでは古い構造と新しい構造を同時に持つことができるというのも特徴です。

これは、アプリケーションの進化に応じて柔軟なデータベースを苦労なく保てるという利点があります。

DynamoDBはオートスケーリングにも対応しており、負荷に対して柔軟です。

ストレージの拡張なども自動で行えます。

多数のユーザーが高い頻度でアクセスを繰り返すようなDBには非常に有効で、低レイテンシーで柔軟な運用を行うことができます。

また、DynamoDBでは、インフラストラクチャは完全にアマゾンが管理しており、これについて気にする必要もありません。

データの検索方法は基本的にはKVSですが、データに紐づけられた属性から検索を行うことも可能です。

しかし、その方法はパフォーマンスに良くない影響を与えるでしょう。

そのため、複雑なデータ管理には向いていないといえます。

そういった場合はRDSを使うと良いでしょうAmazon ElastiCache

キャッシュを行う機能です。

「キャッシュ」

よく使うデータを高速低用量のメモリ内に保存しておくことで、次回使用時に素早くデータを取り出し使用できる機能つまり、アプリケーションの速度を高速化するための機能です。

RedisとMemcachedという既存のキャッシュシステムに対応しています。

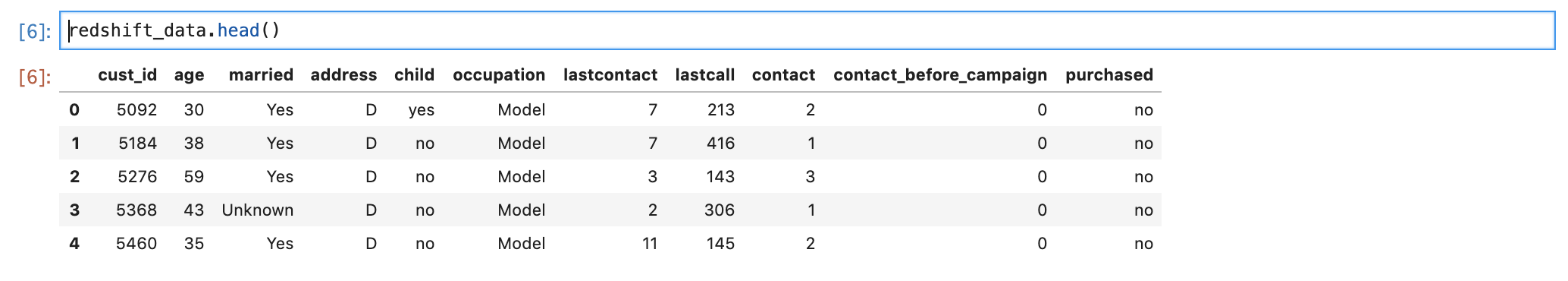

RDBの紹介の時に、KVSが早くてSQLをつかうRDBは遅いという話をしましたが、RedisはNoSQL、つまり高速なデータ検索を可能にするシステムです。Amazon Redshift

これは高速なデータウェアハウスです。

「データウェアハウス」

データを時系列順で保管する倉庫で、書き換えや部分的な消去などができません。

データベースは今の状態を記録し更新することに強みがありますが、データウェアハウスは連続したデータの履歴保管が主な用途です。

SQLや既存のBIツール(データ分析ツール)を使って高度なデータ分析を行えます。

しかも、高速に大量のデータを処理できます。

料金は使用した分だけかかりますが、1時間当たり25セントからです。

年間でテラバイトあたり1000ドル程度の料金で処理でき、これは従来のデータウェアハウス製品の1/10のコストしかかかっていないことを表します。

しかもデータの扱いは保管中でも通信中でもすべて暗号化されているため、安心安全です。

ビックデータの解析などにも向いているといえるでしょう。Redshift Spectrum を使うと、Amazon S3 に保存されたオープンデータフォーマットに直接クエリを実行することもできます。

また、これらを使用した分析サイクルを自動化することは非常に簡単で、ユーザーはそのデータを使ったビジネスの改善に集中することができるようになります。Amazon CloudWatch

AWSのクラウドリソースと実行されるアプリケーションをモニタリングするサービス

ログの収集やモニタリング、アラーム設定などが行える。Amazon CloudTrail

AWS内で、だれがいつどこで何をしたかを監視しているサービス。

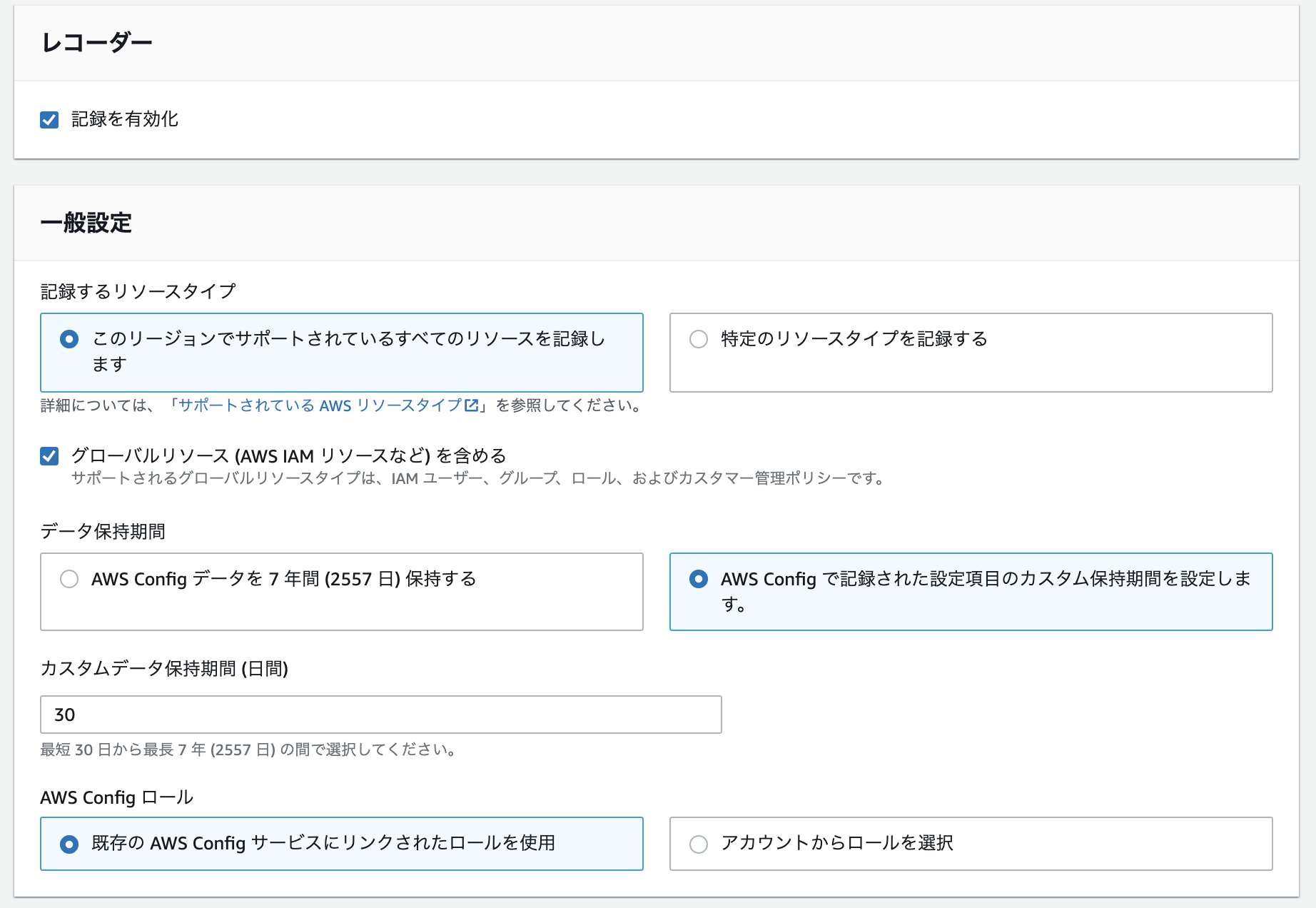

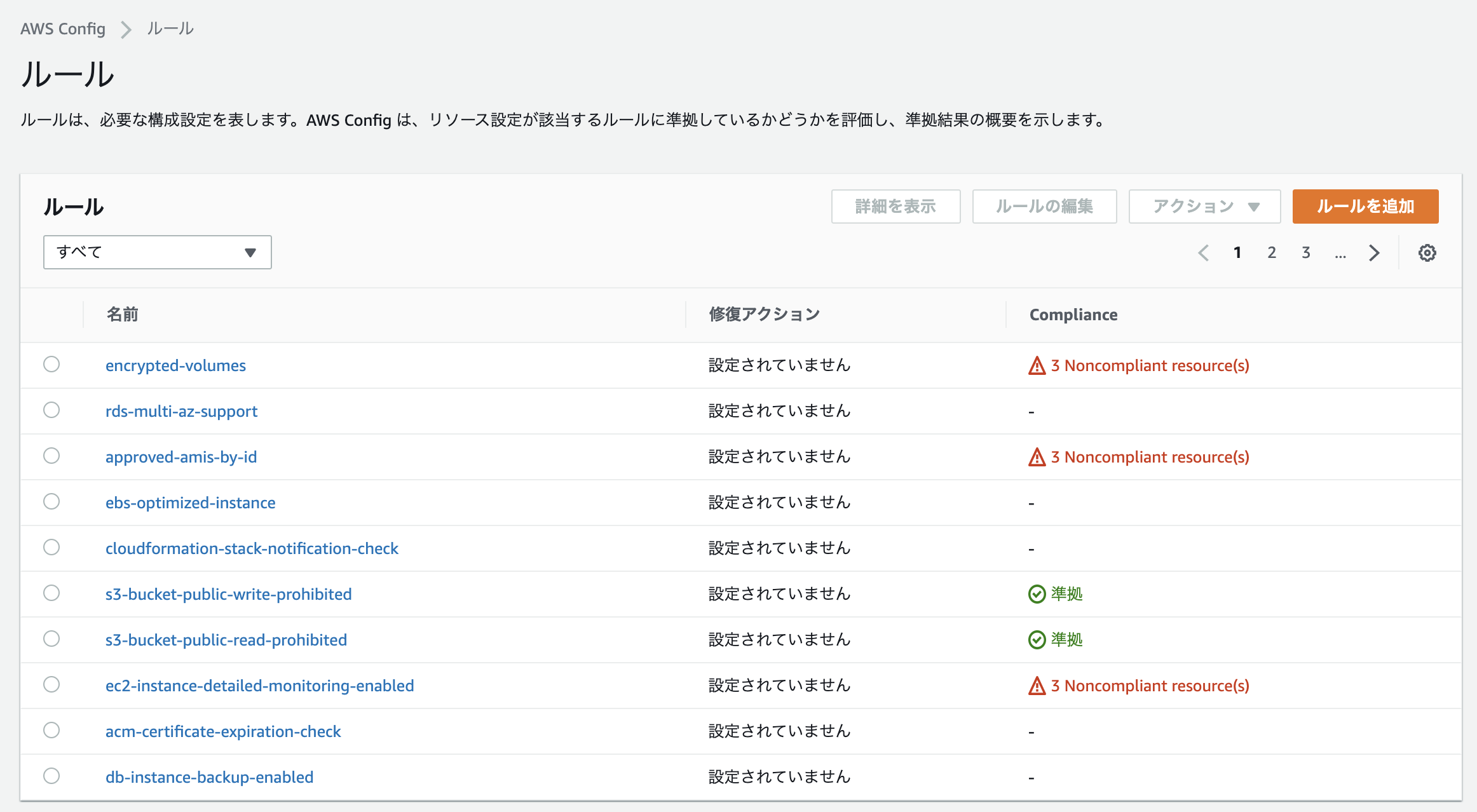

何らかの想定外な作業が確認された場合は、ここから誰が作業したのかを確認することができる。AWS Config

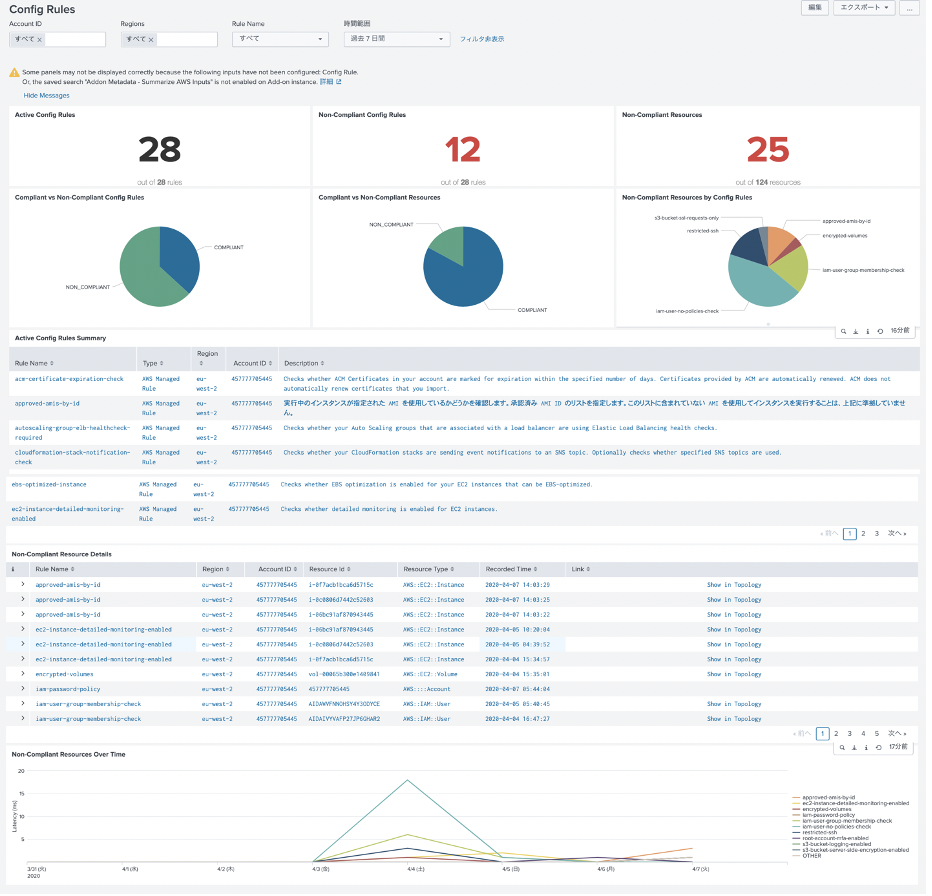

AWSのセキュリティと統治を行うための機能で、構成変更を通知したり履歴を確認したりするだけでなく、あらかじめルールを記載しておくことで、AWSリソースがルールに従って構築されているかを確認したりもできます。

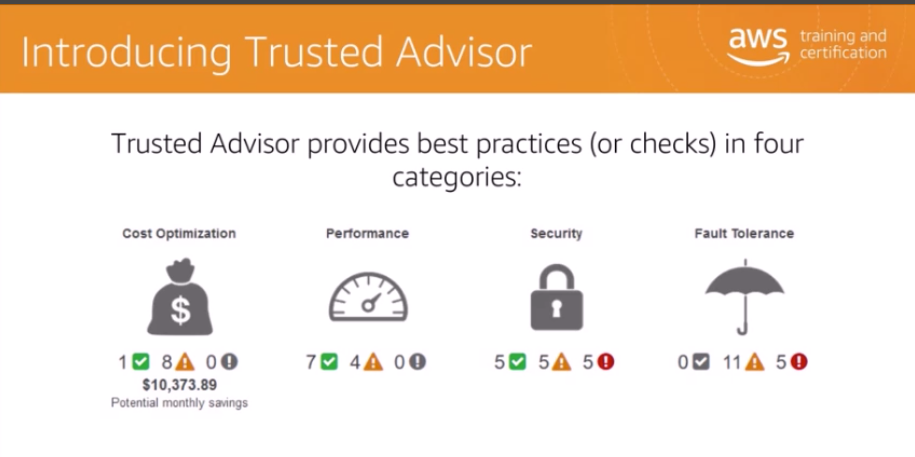

Amazon Trusted Advisor

AWSを使用していると、リソースのあれやこれやと確認したいものが出てくるわけですが、AWSでは所有するリソースは膨大です。

たとえば、全く使われていないストレージや、動作していないインスタンスにアタッチされたEIPなど、お金はかかるが最適化されていないもの、有ったらどうにかしたいものなどは無数にありますね。Trusted Advisorは、アカウントのすべてのリソースをチェックし、ベストプラクティスを提供してくれます。

これは、サービスの制限・セキュリティ・耐障害性・パフォーマンス・コストのそれぞれ項目で実行されます。これはコンソール画面の一部ですが、一目でどの分野に問題があり、どれくらいコストが無駄になっているかを見ることができます。

さらに、この機能にはapiも用意されており、自動でこれらを適用することも可能です。Amazon CloudFormation

AWSのリソースを使った構成まるごとをテンプレートという形に落とし込むことで、依存関係などを一切考慮せずに環境構築を行うことができます。

つまるところ、インフラを設定ファイルのようにまとめてしまえます。テンプレートをyamlやjsonで書いて、cloudFormationでスタックにする。

スタックはリソースの集合体を表していて、要は環境丸ごとまとめたものだと思えばよい。

スタック内部のリソースをどういった順番で構築するかなどはCloudFormationが自動的におこなってくれる。AWSで環境構築などを行う際に、Cloudformationのテンプレートをコードで管理して複数のリソースの集合体を管理したりします。

同じような環境を顧客ごとに立てたりする場合は、必須に近いサービスです。AWS OpsWorks

AWSインスタンスに対してChefを使える機能

「Chef」

ファイルに記述した設定内容に応じて自動的にユーザーの作成やパッケージのインストール、設定ファイルの編集などを行うツール

自動化につかうAmazon Batch

バッチ処理を行うためのサービス

バッチ処理は大量のデータを決められたルールで処理していくというようなものが多く、非常に時間もかかる。

AWS Batchは、処理データの要領などによって動的にコンピューティングリソースを決定し、高いパフォーマンスで処理を行える。「バッチ処理」

あらかじめ定めた処理を順次実行すること。

営業時間中に行われた処理に対して、大量のデータを夜中のうちに加工したりするのにつかわれることがおおい。Amazon simple Queue Service SQS

メッセージキューイングを行う機能です。

メッセージを保管しておくことができます。「メッセージキューイング」

あるプログラムが送信したメッセージを格納しておく

そのメッセージは取り出されるまではそこにおり、そのメッセージを必要とするプログラムが何らかのタイミングでメッセージを受け取りに行くことができる。

そして、そのプログラムは受け取ったメッセージに応じて動くという機構。

先に入れたものを先に取り出すFIFO(ファストインファストアウト)とかその逆のFILOとか取り出しの順番がきまってたりする。

それによってスタックとキューで名前が分かれてたりする。

非同期で動くプログラムどうして連携を取りたいケースなどに使用する。「非同期」

Aが実行されるまでBは待機するという状態を同期しているという。

非同期は逆で、Aを実行したらその結果を待たずにBも動けること、を表す。Amazon simple Notification Service SNS

これはメッセージをためておくSQSと違って、メッセージを送るための機能です。

Amazon SNS を利用すれば、アプリケーションは「プッシュ」メカニズムを使用して、複数のサブスクライバーにタイミングが重要なメッセージを送信することができます。

そのため、更新を定期的に確認したり、ポーリング(一定間隔で順繰りに要求がないか尋ねる)したりする必要性がなくなりますAmazon EC2 Container Service ECS

Dockerコンテナを使うための機能です。

「Docker」

EC2のような仮想環境をつくるためのツール。

windowsのなかにlinux環境を用意したりできるため、AWS以外でも広く使われているもともと仮想環境を使用していたユーザーとしてはDockerはEC2よりもなじみ深いものですし、既にdockerが提供する優れた環境もたくさんあるので、EC2ではdockerをより利用しやすくしつつそのまま使えるようになっています

Amazon EC2 Container Registry ECR

dockerにもEC2でいうAMIのようなイメージ存在し、それを利用することで簡単に環境を立てることができる。

ECRはそういったDockerコンテナのレジストリである「レジストリ」

情報を保存しておくデータベース

Windows OSが設定情報を保存しておくデータベースをレジストリと呼んでいる。Amazon Lightsail

こちらも仮想サーバーを立てるためのサービスで、数分でプライベートなクラウド環境を構築できる。

サーバー料金にインターネット転送料金やディスク料金が含まれているのが特徴的で、VPCも専用の物が用意されるのでEC2と連携したりするのは苦手(無理ではない)、後停止していても金がかかる

インターネットへの転送料金に追加のお金がかからないので、サーバー1台で運用する、画像や動画など配信データ量が比較的多いWebサイト向け。

ロードバランサーとかはないので、簡単にサーバー立ち上げてちょっと使って本運用はEC2とか、おためしにもいい。AWS Elastic Beanstalk

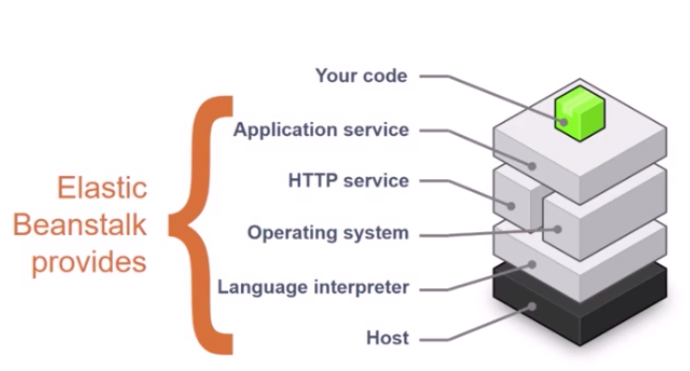

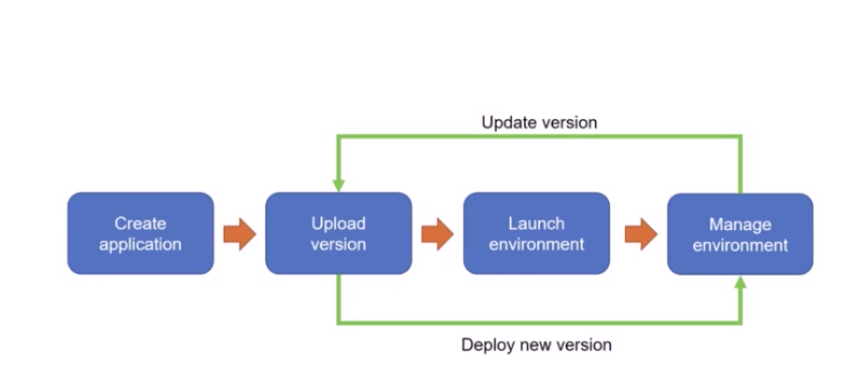

Elastic Beanstalk を使用すると、アプリケーションを実行しているインフラストラクチャについて考えることなく、AWS クラウドでアプリケーションのデプロイと管理を簡単に行うことができます。

我々は単にそのアプリケーションをアップロードするだけで、Elastic Beanstalk がキャパシティーのプロビジョニング、ロードバランシング、スケーリング、およびアプリケーション状態モニタリングといった詳細を自動的に処理します。

しかも、Elastic Beanstalk に関して別途料金が発生することはありません。Elastic Beanstarkはplatform as a service (PaaS)です。

Paasとは、ネットワークを通じたサービスとして、アプリケーションを利用するためのプラットフォーム(土台)を顧客に提供する形態をいいます。

なんやかんや言いますが、Elastic Beanstalkがサポートしている言語で書かれたコードを、自分の環境に簡単に配置・管理できますよという話です。

Elastic Beanstalk は、Go、Java、PHP、.NET、Node.js、PHP、Python、および Ruby で作成されたアプリケーションと、各言語に対応するさまざまな種類のプラットフォーム設定をサポートしています。以下のように、ホストコンピュータやOS、アプリケーション実行サービスやHTTPサービスも用意してくれているので、我々は、アプリケーションをAPサービスに、画面情報をHTTPサービスに渡すだけでアプリケーションを動かせるのです。

また、この環境への負荷があがれば、自動でスケーリングしたり、それによって増設されたAPサーバーに適切なロードバランシングを自動で行ってくれますよというサービスですね。

我々がやるべきことはコードを書いて、アップロードするだけです。

コードがアップロードされると、AWS Elastic Beanstalkはコードの実行に必要な環境を自動で起動して管理もやってくれます。

アプリケーションを運用するためのインフラをAWS上に構築するためには、AWSの知識はもちろんのこと、OSやネットワーク等について多様な知識が必要です。

AWSは、各システム固有の細かい要件に柔軟に対応するために、詳細で複雑な設定項目が無数にあり、正直なところ一朝一夕でどうにかなる知識の量ではありません。

(この記事が鬼長いことでもわかると思います)ただ、逆に考えれば「細かい要求はしない、とにかくオススメのインフラをくれ、アプリケーションはそれに合わせて作る」と割り切れるのであれば、複雑な部分を隠蔽した状態で、シンプルにAWSを利用できるはずです。

Elastic Beanstalkはそのような要求に応えるサービスです。オンプレからAWSへの移行用サービス

AWS Application Discovery Service ADS

サーバーやストレージ、ネットワーク機器から設定や使用状況のデータを自動収集し、アプリケーションのリストや動作方法、依存関係を把握できるサービス。

AWS Database Migration Service DMS

データベース移行用のサービス

処理中も移行元のデータベースは動かしたままで問題ありませんし、oracleからAuroraというような別のDBへの移行もサポートしています。AWS Server Migration Service SMS

オンプレミスの VMware vSphere または Microsoft Hyper-V/SCVMM 仮想マシンの AWS クラウド AWS SMS への移行を自動化

AWS Organizations

アカウント一元管理を行えます。

たとえば、複数アカウント使用している場合に請求を一回にまとめたりできます。AWS inspector

セキュリティを評価できます。

Amazon Inspector では、自動的にアプリケーションを評価し、露出、脆弱性、ベストプラクティスからの逸脱がないかどうかを確認できます。

評価の実行後、重大性の順に結果を表示した詳細なリストが Amazon Inspector によって作成されます。

この調査結果は直接確認することもできますが、Amazon Inspector コンソールまたは API を介して入手可能な詳細な評価レポートで確認することもきます。AWS Server Migration Service SMS

オンプレミスの VMware vSphere または Microsoft Hyper-V/SCVMM 仮想マシンの AWS クラウド AWS SMS への移行を自動化

AWS snowbal

AWSとオンプレ環境の間で大量のデータ転送を行えるサービス

AWSのセキュリティ

責任共有モデル

AWSは様々な機能を提供していますが、あくまでこれは何かを成し遂げるためのツールを提供しているにすぎません。

そのため、AWSとユーザー、それぞれが責任を持つべき領域が存在します。

そのため、AWSのユーザーはこの責任共有モデルについて理解する必要があります。AWSの責任範囲

AWSはクラウドのセキュリティに責任を負います。

これは、AWSを運営するのに必要な物理的なサーバーなどのすべてのグローバルインフラストラクチャを保護する責任があるという意味です。

そのため、自信によって物理的なサーバーが故障し、AWSが動かなくなったとしてもユーザーに責任は在りません。

リージョン・アベイラビリティゾーン・エッジロケーションに含まれるもの等、すべてAWSの責任です。

また、それだけでなくデータベースやストレージ、ネットワーキングなどの基本的とみなされた製品のセキュリティ設定にも責任を持っています。

これらのサービスが使用するオペレーティングシステム(OS)やパッチ適用などもAWSの責任となりますユーザーの責任範囲

ユーザーはクラウド上に保存するあらゆるものを保護する責任を負います。

例えば、データベース自体のパッチ適用などの管理はAWSの仕事ですが、そのデータベースをプライベートなネットワークに設置してデータに対しての外部からの攻撃に備えるのはユーザーの仕事です。

以下のようなものが対象となります。

- AWSに保存するコンテンツ

- コンテンツで使用されるサービス

- コンテンツが保存される国(リージョンの選択)

- コンテンツの形式・構造、暗号化など

- コンテンツにアクセスできるユーザーの制御EC2やVPCなど、Iaasのカテゴリに分類される製品はユーザーがすべて管理します。

「Iaas」

Infrastructure as a Service

IaaSはサーバーやストレージ、ネットワークなどのハードウェアやインフラまでを提供するクラウドサービスの総称「Paas」

Platform as a Service

システム開発に必要なアプリケーションとOSをつなぐミドルウェアやデータベース管理システム、プログラミング言語、WebサーバーOSなどといったソフトウェア一式を提供してくれます。「Saas」

Software as a Service

従来はパッケージとして提供されていたアプリケーションを、インターネット上で利用する提供形態です。

エンドユーザーにとっては、このSaaSが一番なじみのあるクラウドサービスかもしれません。

端末にアプリケーションをインストールすることなく、必要なサービスをインターネット経由で手軽に利用することができます。セキュリティサービスの紹介

AWSのセキュリティ用件は、最も厳しい顧客のニーズを満たすように設計されています。

Identity and AccessManagement 、 ログ作成とモニタリング、 暗号化とキー管理、 ネットワークのセグメンテーション、 DDos保護など様々なセキュリティサービスは、ほぼ追加料金なしで使用することができます。(使用した分だけお金がかかるものもあります)

これらのサービスを、オンプレミス環境にインフラを構築するよりもはるかに低い運用オーバーヘッドで、ニーズに合わせて使用できます。「オーバーヘッド」

システムを利用するための付加的処理や、余分な時間などAWSでは、ネットワークや構成管理、アクセスやデータについて、セキュリティに特化したツールを提供しています。

加えて、モニタリングやログ作成機能を使うことで、環境内の出来事を完全に可視化できます。ネットワークについては、プライベート(社内)からのアクセスのみを許可したり、パブリックなネットワークを構築したりできます。

全サーバーにおいて、データのやり取りはTransport Layer Securityによって暗号化され、AutoScalingやコンテンツ配信戦略の一部としてDDosを緩和する技術もあります。「DDos」

コンピュータに対して複数のマシンから大量の処理負荷を与えることでサービスを機能停止状態へ追い込む手法

AWSにはクラウドリソースを組織の基準とベストプラクティスに準拠させつつ、スピードを向上させるための幅広いツールが用意されています。

AWSリソースを組織の基準に従って行うためのデプロイツールや、AWSリソースへの変更を追跡管理するインベントリおよび構成管理ツール、EC2インスタンス向けに標準的な設定済みの強固な仮想マシンを作成するテンプレート定義および管理ツールがあります。

AWSはクラウド内に保管しているデータにセキュリティレイヤーを追加し、スケーラブルで効率的な暗号化機能を提供します。

EBS S3 Glacier RDS Redshift などのストレージやデータベースサービスで利用できるデータ暗号化機能もあります。

また、AWS内で開発されたりデプロイされたサービスにも暗号化とデータ保護を行えます。

AWSではサービス全体に対してユーザーアクセスポリシーを定義し、管理します。

例えば、個々のアカウントにAWSリソース全体での権限を定義できるIdentity and Access Managementや

ハードウェアによる認証をおこなえるMulti-Factor Authenticationなどがあります。

AWSには、環境で何が起きているかを把握することができるツールがあります。

例えば、APIをコールした実行者や内容・時間・発生地点などに関する高い可視性や調査とコンプライアンスレポートを容易にするログ収集オプション。

特定の閾値を条件としたアラート機能などがあります。「コンプライアンスレポート」

監督当局や官公庁によって定められる規則、標準、法律、規制などに準拠することを目的として企業によって作成されるレポートを指します。ユーザーはAWS Service Catalogを使用することができます。

これは、IT管理部門向けには、CloudFormationのテンプレートとして管理されるAWSリソース定義や、これらの利用権限をカタログとして一元管理する機能を提供します。

ユーザ部門ではIT管理部門が作成したカタログより、求める機能に応じたAWS環境を必要に応じて起動する事が可能となります。

CloudFormationはテンプレートに記載された内容でインスタンスを立てたりできる機能ですが、これは通常そこで使用されるすべてのAWSサービスに対してIAMによる許可が必要になります。

しかし、権限を広範囲に付与するのは危険といえます。

そのため、この機能はIT管理者が問題ないと提示したテンプレートを作成でき、ユーザーはそれを使用してインスタンスを立てることができるようになる機能です。

そのテンプレートの集合体をポートフォリオといいます。AWS Marketplaceでは、皆さんのオンプレミス環境にある既存の制御と同等かそれ以上の制御を行える、業界のトップ製品が多数提供されています。

ここにはマルウェア対策やウェブアプリケーションファイアーウォール、侵入に対しての保護なども含まれます。

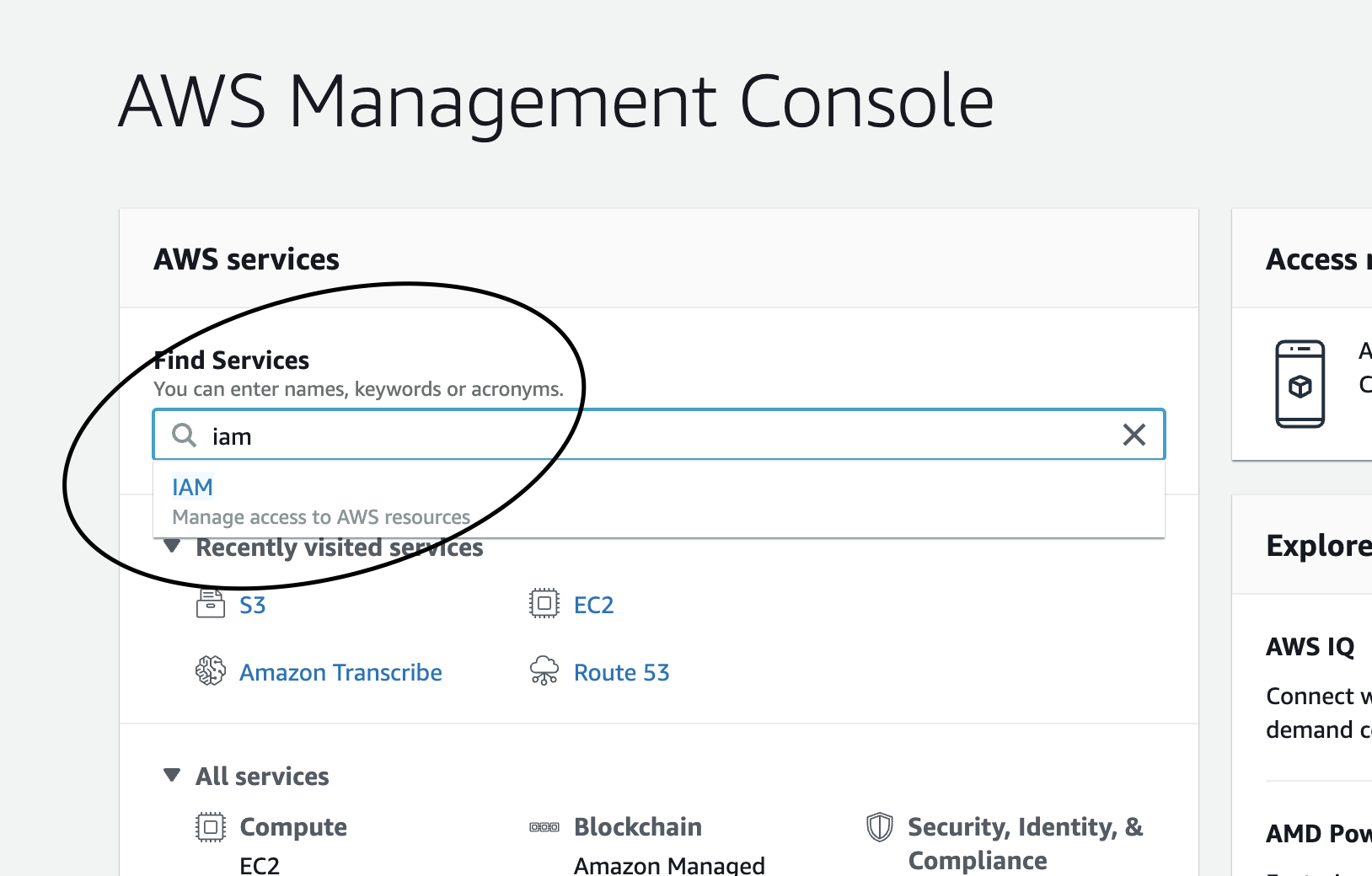

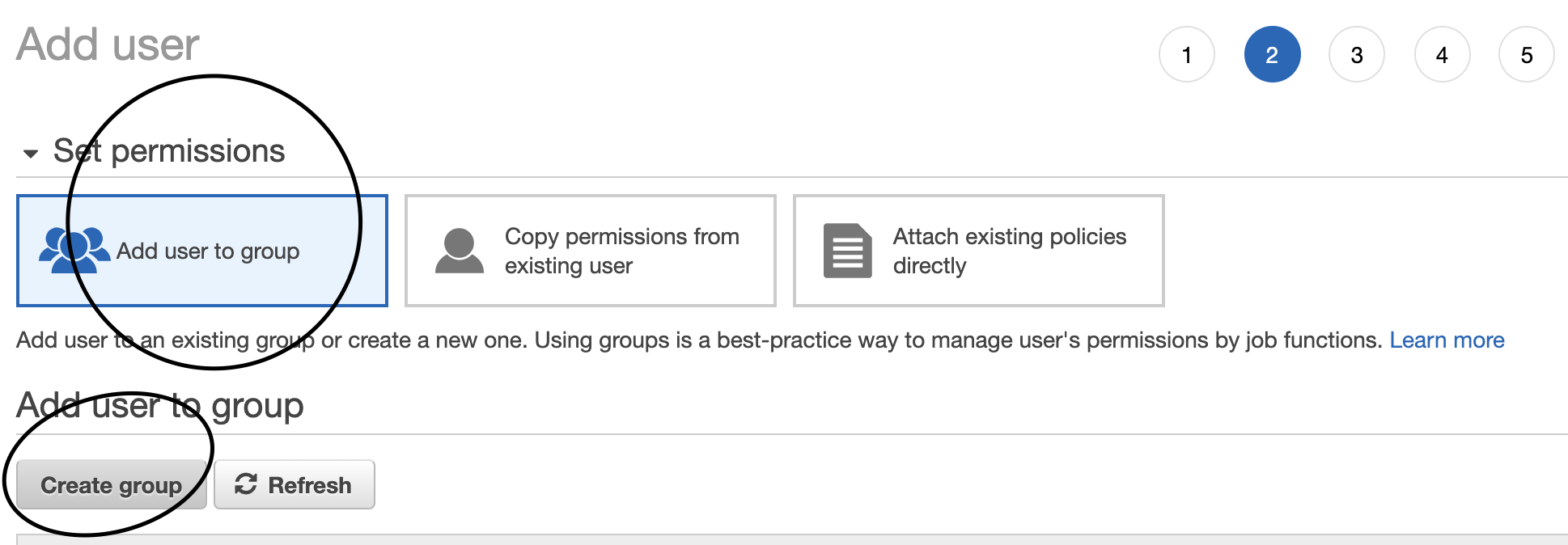

これらの製品がAWSの様々な機能を補完し、顧客のニーズに合わせたセキュリティを実現できます。アクセスコントロール IAM

AWSのあらゆるサービスへのアクセスは、アカウントに対して付与する権限の有無によってコントロールすることができます。

これを行うのがIAM(Identity and Access Management)です。

IAMでは以下のことが行えます。

- IAMユーザーとそのアクセス権限の管理(アカウントのID/PW等の管理)

- IAMロールとその権限の管理(サービスに対しての権限管理)

- フェデレーションユーザーとその権限の管理「フェデレーション」

複数のインターネット サービス間のユーザ認証連携を意味します。

複数のサービスで認証情報を共有することで、1度のユーザ認証で複数のサービスを利用可能にします。アクセスコントロールのベストプラクティス

1.AWSリソースに無制限にアクセスできるルートアカウントのアクセスキーを削除します。 代わりにIAMユーザーアクセスキーか、一時的なセキュリティ認証を使用します。 2.アカウントのセキュリティを確保するために、AWSルートアカウントでMFAを有効にして保護を強化します。 3.IAMユーザーを作成し、必要な権限のみ付与します。 ルートアカウントは権限が強く危険なため、日常的には使用しません。 4.ユーザー単位で権限を管理するのは複雑なので、IAMユーザーグループの単位で権限を管理します。 5.IAMパスワードポリシーを使用し、定期的なパスワード変更をおこないます。 6.EC2インスタンスで実行されるアプリケーションに対してIAMロールを使用してアクセスできるサービスを制限します。 7.強い権限で作業をする場合はユーザーの認証情報を共有するのではなく、ロールを使用して権限を委任します。 8.退職者など不要なユーザーは常に削除します。 9.ポリシー条件を使用してセキュリティを強化します。 10.AWSアカウントのアクティビティをCloudTrailでモニタリングし、誰がどこで何をしたかをCloudWatchで記録します。コンプライアンスプログラム

AWSでは以下のようにコンプライアンスをサポートしている。

「コンプライアンス」

法令遵守、企業などが、法令や規則をよく守ること。保証プログラムを含むAWSのコンプライアンスアプローチ

- 業界の認証と独立したサードパティ認証機関による証明書の取得

- AWSのセキュリティと統制の方法に関する情報をホワイトペーパー及びウェブサイトコンテンツで公表

- NDAに基づいて証明書やレポートなどのドキュメントを提供

「NDA」

秘密保持契約(NDA)とは、取引を行う上で知った相手方の営業秘密や顧客の個人情報などを、取引の目的以外に利用したり、他人に開示・漏洩することを、禁止する契約のことです。リスク管理、統制環境、情報セキュリティといった、AWSのリスク管理とコンプライアンスプログラム

下記ページにて、コンプライアンスプログラムごとにどのような対応がされているかなどを確認できる。

https://aws.amazon.com/jp/compliance/programs/AWSのユーザーが担うべきコンプライアンスの責任

AWSはあらゆるコンプライアンスプログラムに対応しており、AWSが提供するサービスは適切な設定を行うことでコンプライアンスを守ることができる。

なので、ユーザーは自分が守るべきコンプライアンスを理解し、適切な運用を行うことが求められる。

そのための機能はAWSが提供するし、ドキュメントも用意する。

つまり、コンプライアンスの達成にはAWSとユーザーの連携が必要であるということです。コンプライアンスを守るためには、以下のようなステップを踏むと良い。

確認 AWSから提供される情報や他の情報を確認して、IT環境全体について可能な限り多くのことを把握してから、全てのコンプライアンス要件をドキュメント化します。 設計 エンタープライズのコンプライアンス要件を満たすために統制目標を設計及び実装 特定 サードパーティが所有する統制を特定及びドキュメント化します。 検証 統制目標がすべて達成され、主要な統制がすべて効果的に設計及び運用されていることを確認します。様々なサポート

AWSクラウド上に保管されるユーザーのデータを保護する様々な取り組みを紹介します。

AWS Trusted Advisor AWSリソースの問題を自動で見つけ、可視化してくれるオンラインツール。 AWSアカウントチーム ユーザーからの最初の問い合わせ窓口 セキュリティ問題を解消するための適切なリソースを紹介してくれる。 AWSエンタープライズサポート 15分以内対応、24時間サポート年中無休で電話・チャット・メール対応してくれる。 専任のテクニカルアカウントマネージャによるコンシェルジュサービス AWSプロフェッショナルサービス/AWSパートナーネットワーク プロフェッショナルサービスはAWS クラウドを使用して期待するビジネス上の成果を実現するようお客様をサポートできる、専門家からなるグローバルチームです。 パートナーネットワークはAWSを使う側の企業が所属するネットワークで、AWSのサービスや技術に長けたベンダーとして公式サイトで紹介され、いち早く新たなサービス・技術の試用ができたり、技術者向けに特別な教育を受けることができる制度です。 どちらも、実証済みの設計に基づいてお客様のセキュリティポリシー及びセキュリティ手順の構築をサポートします。 AWS勧告・速報 現在判明している脆弱性や脅威を提供 AWS監査人のラーニングパス 監査人・コンプライアンス・法的なロールの担当者はAWSを使って内部オペレーションのコンプライアンスを実現する方法を学ぶことができます。 AWSコンプライアンスソリューションガイド コンプライアンスに関して、何から手を付けてよいかわからないというときは、こちらから学習をすることができます。AWSにおける設計原則

自社のインフラストラクチャをベストプラクティスにのっとってAWSで構築するためのサポートとして設計のフレームワークは用意されています。

AWSでは5つの柱に基づいてアーキテクチャを設計します。「フレームワーク」

枠組み、決まりきった手順

ITにおいては、みんなが使いそうな決まりきったプログラムがあらかじめ用意されており、穴埋めするだけで目標とするものが完成するようなひな形を指すこともある。

ここでは決まりきった手順の意味。アーキテクチャ設計における5つの柱

セキュリティ

IAM リソースへのアクセス制限 検出制御 ログの取得と分析など インフラストラクチャの保護 ネットワークの分割やパッチ適用、ファイヤーウォールやゲートウェイなど外部からの侵入への対処 データの保護 データの分類や暗号化、バックアップ、複製復旧 インシデントへの対応 インシデントへの対応プロセスの手順化セキュリティ設計原則

「全てのレイヤーにセキュリティを適用する。」 どの場所にあるインフラもすべてのレイヤーが保護されてなければなりません。 「追跡可能性の実現」 あらゆるアクションを記録し監査し、だれがいつどこで何をしたのかを把握できる必要があります。 「自社システムの保護」 基本的に、AWSはインフラとサービスにおいてセキュリティを担保しているので、ユーザーは自社システムの保護に全力をつぎ込むべきです。 「セキュリティのベストプラクティスを自動化」 例えば、日常的もしくは異常なセキュリティイベントへの対応などは自動化されるべきです。信頼性

これは、障害児の復旧能力と、アクセス量に対してのシステムの速度など需要を満たす機能を指します。

クラウド上の信頼性は以下の要素で担保されます。基盤 アーキテクチャやシステムの基礎的な要素が綿密に計画され、確固としたものであり、需要や要件の変化に対応で木、障害を自動で復旧できる仕組みを用意しましょう。 変更管理 システムを構築する前に、信頼性に影響を与える基盤の要件を整えておく必要があります。 変更管理は、変更によってシステムが受ける影響を完全に理解し、意識することです。 障害管理 障害管理は、システムを変更する前に前もって計画を立ててシステムをモニタリングし、予測し、検知し、対応することに加え障害発生を未然に防ぐことです。信頼性設計原則

「復旧手順のテスト」 実際に障害が発生しなくても、シミュレーションが簡単に行えるのがクラウドなので、実際の障害が発生する前に確認しましょう。 「障害からの自動復旧」 AWSでは閾値を超えた瞬間にアラートするようなっていも、それを受けとってプログラムを実施するようなこともできますので、自動かは容易です。 「集計システムの可用性向上」 単一の大規模リソースは、単一障害点になりやすいです。 なので、これらは複数の小規模なリソースに分割することで、システムへの影響を軽減できます。 これを水平スケーリングといいます。 つまり、負荷が高くなったからインスタンスを大きくするというスケーリングではなく、もう一台同じアプリを立てて負荷を分散するほうがよいということです。 「キャパシティを予測しないこと」 自動でスケーリングできるのだから、予測する必要はない。 これぐらい必要だろうで固定のリソースを管理するのではなく、どうであっても対応できるように自動化しよう 「変更管理とオートメーション」 アーキテクチャやインフラストラクチャにて変更を加える際には、自動化する仕組みをつくっておいて、それが対応する範囲のみにとどめるべきです。 そうすることで、個別に単独なのシステムやリソースを調整する必要がなくなります。 ### パフォーマンス効率選別

アーキテクチャを最適化するための最適なソリューションを選定しましょう。レビュー

AWSは仮想化されているがゆえに、リソースのカスタマイズやソリューションの検証が容易です。

そのため、レビューを繰り返して継続的なソリューションのイノベーションを行いましょう。モニタリング

運用が始まったら、パフォーマンスをモニタリングし、問題は影響が出る前に修正する必要があります。

CloudWatchやkinesis、SQSやLambdaなどモニタリングに適した機能も多く取り揃えています。トレードオフ

全てにおいて最高のパフォーマンスを発揮するソリューションは在りません。

一貫性、耐久性、容量を時間やレイテンシーとトレードすることが必要になります。

```パフォーマンス効率設計原則

「最新テクノロジーの標準化」 知識が必要で複雑な実装が難しいテクノロジーは、AWSがサービス化して提供する。 なので、ユーザーはそれをちゃんとキャッチして使っていこう。 「分単位で世界中にデプロイ」 アーキテクチャの変更をしたら、すぐにすべてのシステムにデプロイしましょう。 AWSは世界中の複数リージョンにあるシステムに簡単にデプロイでき、レイテンシーの短縮と顧客サービスの向上を最低限のコストで実現できます。 「サーバーレスアーキテクチャの使用」 インフラ管理がなければ運用コストはなくなり、トランザクションコスト(仲介料)もなくなります。 「頻繁な実験」 仮想化によって既存環境を破壊せずにテストをおこなうことができるようになります。 そのため、従来よりも気軽かつ高速にテストが行えるので、テストを繰り返してシステムの効率を向上させましょう。 「変更管理とオートメーション」 アーキテクチャやインフラストラクチャにて変更を加える際には、自動化する仕組みをつくっておいて、それが対応する範囲のみにとどめるべきです。 そうすることで、個別に単独なのシステムやリソースを調整する必要がなくなります。 「メカニカルシンパシー」 実現しようとすることに最も適した技術を使うコストの最適化

コスト効率の高いリソース コストが十分に最適化されたシステムは、所有するリソースをすべて利用することで最低限のコストで最高のパフォーマンスと機能要件を満たします。 需要と供給の一致 柔軟なスケーリングを実施し、必要な時に必要なだけのリソースを使うべきです。 支出の認識 自分たちの使用するリソースにどれだけのコストがかかっているかを一点の曇りなく把握しましょう。 時間の経過に伴う最適化 設計時ではなく、運用が始まってからも徐々に改善を続けましょうコストの最適化設計原則

「消費モデルの導入」 固定のコストを払い続けるのではなく、使用したコンピューティングリソースの消費量に応じて料金を支払いましょう 「全体的な効率の評価」 システムの生産量とコストのバランスを常に把握しましょう そしてそこから生産量を上げコストを削減したときどれだけの利益が出るかを認識しましょう 「データセンター運用の費用をなくす」 データセンターにかかる費用を自社でもつのではなくすべてAWSでまかなうことで完全になくしましょう 「支出を分析し、帰結させる」 何によっていくらかかっているかを完全に把握しましょう。 これによりどの部分を改善する必要があるかを明確にし、それによってどれだけのコストが軽減できるかを検討できます。 「マネージド型サービスの仕様」 AWSが提供するサービスにはインフラを一切気にしなくてよいS3などのマネージド型サービスもあれば、EC2のようなインフラ構成の把握が必要なサービスもあります。 なるべくサービスをマネージド型サービスに集約することで、運用コストを下げることができます運用上の優秀性

ここではビジネスの価値を提供するためのシステムの実行とモニタリング、および継続的にプロセスと手順を改善することに焦点を当てています。

ここでは以下のことが重要になります。

- 変更の管理

- 自動化

- イベントへの対応

- 日常業務をうまく管理するための標準の定義AWSの料金

料金の基礎

AWSの料金は以下のような特性があります。

従量課金制(使用した分だけお金がかかる)

予測ではなく、ニーズによってお金がかかることで、ビジネスの拡大縮小を自在におこなえるようにしている。

予約による値引き

EC2やRDSのような特定のサービスについてはリザーブドキャパシティー料金が適用されます。

EC2を例にしてみると、リザーブドインスタンスには全額前払い、一部前払い、前払いなしのプランがあり、最大で75%にまで価格が変動します。

基本的には予測ではなくニーズによって料金がかかりますが、完全に予想が立つような分野ではこのような方法でコスト削減を行える可能性があります。使用量が増加するほど、1単位当たりに値引きがかかる

AmazonS3やEC2は、ボリュームディスカウントの精度があります。

つまり、たくさん使えば使うほど安くなります。AWSの拡大にあわせて値引きがかかる

AWS自体の事業拡大や技術革新によっても値下げが行われます。

AWSでは2006年以降すでに44回もの値下げが行われています。

ちなみに、これをスケールメリットといいます。AWSでは、これらの料金要件があわないユーザーのために、大規模プロジェクト向けカスタム料金を設定することもできます。

また、AWSは新規のユーザーが参入しやすいように1年間の無料枠も用意しています。

さらに、AWS上のサービスには常に無料のサービスもいくつかあります。