- 投稿日:2020-03-27T23:05:16+09:00

Rasa NLU で自然言語理解のおためし

NLU (Natural Language Understanding=自然言語理解) をやってみたくて、

https://tech.mof-mof.co.jp/blog/rasa-nlu-japanese.html

を参考にしながら、dockerで環境を作って、実際に動くところまでやってみる。

Docker環境構築

ホストマシン上でrasa用のディレクトリを作る。

$ mkdir rasa $ cd rasa $ vi DockerfileDockerfile に、まずは python が動くimageのみを記述してみる。

FROM python:3.7-slim-stretchdocker-composeで動かしたいので docker-compose.yml を作成

$ vi docker-compose.ymldocker-compose.ymlversion: '2' services: rasa: container_name: rasa build: context: . volumes: - .:/appbuildする

$ docker-compose build Building rasa Step 1/1 : FROM python:3.7-slim-stretch ---> c9ec5ac0f580 Successfully built c9ec5ac0f580 Successfully tagged rasa-test_rasa:latest $python動くか確認。

$ docker-compose run --rm rasa bash Creating network "rasa-test_default" with the default driver root@c02085da1f5f:/# python --version Python 3.7.7 root@c02085da1f5f:/#動いた。

Rasaをインストール

https://tech.mof-mof.co.jp/blog/rasa-nlu-tutorial.html

を参考にrasa環境を作っていく

root@c02085da1f5f:/# pip install rasa ...(なんかいろいろインストールされる) Successfully built sanic-jwt absl-py mattermostwrapper colorclass webexteamssdk SQLAlchemy terminaltables future gast termcolor wrapt PyYAML docopt pyrsistent Failed to build ujson Installing collected packages: ujson, certifi, six, pycparser, cffi, cryptography, future, python-telegram-bot, tqdm, tabulate, python-crfsuite, sklearn-crfsuite, dnspython, pymongo, ruamel.yaml, numpy, h5py, keras-applications, opt-einsum, grpcio, protobuf, absl-py, google-pasta, gast, termcolor, scipy, wrapt, keras-preprocessing, werkzeug, cachetools, pyasn1, pyasn1-modules, rsa, google-auth, chardet, urllib3, idna, requests, markdown, oauthlib, requests-oauthlib, google-auth-oauthlib, tensorboard, tensorflow-estimator, astor, tensorflow, python-dateutil, PyYAML, docopt, pykwalify, zipp, importlib-metadata, pyrsistent, attrs, jsonschema, greenlet, gevent, redis, PyJWT, sanic-jwt, cloudpickle, kafka-python, rocketchat-API, joblib, scikit-learn, pysocks, pytz, twilio, cycler, pyparsing, kiwisolver, matplotlib, mattermostwrapper, multidict, psycopg2-binary, colorclass, aiofiles, rfc3986, hstspreload, hpack, hyperframe, h2, h11, sniffio, httpx, httptools, uvloop, websockets, sanic, requests-toolbelt, webexteamssdk, httplib2, oauth2client, python-engineio, tzlocal, apscheduler, async-generator, wcwidth, prompt-toolkit, questionary, fbmessenger, sanic-plugins-framework, sanic-cors, humanfriendly, coloredlogs, colorhash, jsonpickle, SQLAlchemy, async-timeout, yarl, aiohttp, pydot, packaging, rasa-sdk, python-socketio, tensorflow-hub, decorator, tensorflow-probability, typeguard, tensorflow-addons, terminaltables, networkx, jmespath, docutils, botocore, s3transfer, boto3, slackclient, pika, rasa Running setup.py install for ujson ... error ERROR: Command errored out with exit status 1: command: /usr/local/bin/python -u -c 'import sys, setuptools, tokenize; sys.argv[0] = '"'"'/tmp/pip-install-ingvl92n/ujson/setup.py'"'"'; __file__='"'"'/tmp/pip-install-ingvl92n/ujson/setup.py'"'"';f=getattr(tokenize, '"'"'open'"'"', open)(__file__);code=f.read().replace('"'"'\r\n'"'"', '"'"'\n'"'"');f.close();exec(compile(code, __file__, '"'"'exec'"'"'))' install --record /tmp/pip-record-46isinhm/install-record.txt --single-version-externally-managed --compile --install-headers /usr/local/include/python3.7m/ujson cwd: /tmp/pip-install-ingvl92n/ujson/ Complete output (12 lines): Warning: 'classifiers' should be a list, got type 'filter' running install running build running build_ext building 'ujson' extension creating build creating build/temp.linux-x86_64-3.7 creating build/temp.linux-x86_64-3.7/python creating build/temp.linux-x86_64-3.7/lib gcc -pthread -Wno-unused-result -Wsign-compare -DNDEBUG -g -fwrapv -O3 -Wall -fPIC -I./python -I./lib -I/usr/local/include/python3.7m -c ./python/ujson.c -o build/temp.linux-x86_64-3.7/./python/ujson.o -D_GNU_SOURCE unable to execute 'gcc': No such file or directory error: command 'gcc' failed with exit status 1 ---------------------------------------- ERROR: Command errored out with exit status 1: /usr/local/bin/python -u -c 'import sys, setuptools, tokenize; sys.argv[0] = '"'"'/tmp/pip-install-ingvl92n/ujson/setup.py'"'"'; __file__='"'"'/tmp/pip-install-ingvl92n/ujson/setup.py'"'"';f=getattr(tokenize, '"'"'open'"'"', open)(__file__);code=f.read().replace('"'"'\r\n'"'"', '"'"'\n'"'"');f.close();exec(compile(code, __file__, '"'"'exec'"'"'))' install --record /tmp/pip-record-46isinhm/install-record.txt --single-version-externally-managed --compile --install-headers /usr/local/include/python3.7m/ujson Check the logs for full command output. root@c02085da1f5f:/#なんかエラー出た。

unable to execute 'gcc': No such file or directoryってことなので、それっぽいのをインストールするroot@c02085da1f5f:/# apt-get update -q -y && apt-get install -q -y build-essential ...(なんかいろいろインストールされる) update-alternatives: using /usr/bin/g++ to provide /usr/bin/c++ (c++) in auto mode Setting up build-essential (12.3) ... Processing triggers for libc-bin (2.24-11+deb9u4) ... root@c02085da1f5f:/#もっかいrasaのインストールにチャレンジ

root@c02085da1f5f:/# pip install rasa ...(なんかいろいろインストールされる) Successfully built ujson Installing collected packages: six, absl-py, cycler, python-dateutil, kiwisolver, numpy, pyparsing, matplotlib, docopt, PyYAML, pykwalify, protobuf, tensorflow-hub, kafka-python, pytz, multidict, pysocks, urllib3, certifi, idna, chardet, requests, PyJWT, twilio, fbmessenger, ruamel.yaml, yarl, attrs, async-timeout, aiohttp, slackclient, terminaltables, aiofiles, httptools, websockets, ujson, h11, hpack, hyperframe, h2, sniffio, rfc3986, hstspreload, httpx, uvloop, sanic, sanic-plugins-framework, sanic-cors, humanfriendly, coloredlogs, rasa-sdk, tzlocal, apscheduler, packaging, typeguard, tensorflow-addons, greenlet, gevent, pika, scipy, google-pasta, astor, termcolor, wrapt, grpcio, pyasn1, pyasn1-modules, rsa, cachetools, google-auth, werkzeug, markdown, oauthlib, requests-oauthlib, google-auth-oauthlib, tensorboard, h5py, keras-applications, tensorflow-estimator, keras-preprocessing, opt-einsum, gast, tensorflow, cloudpickle, decorator, tensorflow-probability, dnspython, pymongo, python-engineio, joblib, scikit-learn, httplib2, oauth2client, SQLAlchemy, requests-toolbelt, future, webexteamssdk, sanic-jwt, wcwidth, prompt-toolkit, colorhash, colorclass, tqdm, rocketchat-API, jmespath, docutils, botocore, s3transfer, boto3, questionary, zipp, importlib-metadata, pyrsistent, jsonschema, mattermostwrapper, jsonpickle, python-socketio, redis, pydot, networkx, pycparser, cffi, cryptography, python-telegram-bot, psycopg2-binary, async-generator, python-crfsuite, tabulate, sklearn-crfsuite, rasa Successfully installed PyJWT-1.7.1 PyYAML-5.3.1 SQLAlchemy-1.3.15 absl-py-0.9.0 aiofiles-0.4.0 aiohttp-3.6.2 apscheduler-3.6.3 astor-0.8.1 async-generator-1.10 async-timeout-3.0.1 attrs-19.3.0 boto3-1.12.30 botocore-1.15.30 cachetools-4.0.0 certifi-2019.11.28 cffi-1.14.0 chardet-3.0.4 cloudpickle-1.2.2 colorclass-2.2.0 coloredlogs-10.0 colorhash-1.0.2 cryptography-2.8 cycler-0.10.0 decorator-4.4.2 dnspython-1.16.0 docopt-0.6.2 docutils-0.15.2 fbmessenger-6.0.0 future-0.18.2 gast-0.2.2 gevent-1.4.0 google-auth-1.12.0 google-auth-oauthlib-0.4.1 google-pasta-0.2.0 greenlet-0.4.15 grpcio-1.27.2 h11-0.8.1 h2-3.2.0 h5py-2.10.0 hpack-3.0.0 hstspreload-2020.3.25 httplib2-0.17.0 httptools-0.1.1 httpx-0.9.3 humanfriendly-8.1 hyperframe-5.2.0 idna-2.9 importlib-metadata-1.5.2 jmespath-0.9.5 joblib-0.14.1 jsonpickle-1.3 jsonschema-3.2.0 kafka-python-1.4.7 keras-applications-1.0.8 keras-preprocessing-1.1.0 kiwisolver-1.1.0 markdown-3.2.1 matplotlib-3.1.3 mattermostwrapper-2.2 multidict-4.7.5 networkx-2.4 numpy-1.18.2 oauth2client-4.1.3 oauthlib-3.1.0 opt-einsum-3.2.0 packaging-19.0 pika-1.1.0 prompt-toolkit-2.0.10 protobuf-3.11.3 psycopg2-binary-2.8.4 pyasn1-0.4.8 pyasn1-modules-0.2.8 pycparser-2.20 pydot-1.4.1 pykwalify-1.7.0 pymongo-3.8.0 pyparsing-2.4.6 pyrsistent-0.16.0 pysocks-1.7.1 python-crfsuite-0.9.7 python-dateutil-2.8.1 python-engineio-3.11.2 python-socketio-4.4.0 python-telegram-bot-11.1.0 pytz-2019.3 questionary-1.5.1 rasa-1.9.2 rasa-sdk-1.9.0 redis-3.4.1 requests-2.23.0 requests-oauthlib-1.3.0 requests-toolbelt-0.9.1 rfc3986-1.3.2 rocketchat-API-0.6.36 rsa-4.0 ruamel.yaml-0.15.100 s3transfer-0.3.3 sanic-19.12.2 sanic-cors-0.10.0.post3 sanic-jwt-1.3.2 sanic-plugins-framework-0.9.2 scikit-learn-0.22.2.post1 scipy-1.4.1 six-1.14.0 sklearn-crfsuite-0.3.6 slackclient-2.5.0 sniffio-1.1.0 tabulate-0.8.7 tensorboard-2.1.1 tensorflow-2.1.0 tensorflow-addons-0.8.3 tensorflow-estimator-2.1.0 tensorflow-hub-0.7.0 tensorflow-probability-0.7.0 termcolor-1.1.0 terminaltables-3.1.0 tqdm-4.31.1 twilio-6.26.3 typeguard-2.7.1 tzlocal-2.0.0 ujson-1.35 urllib3-1.25.8 uvloop-0.14.0 wcwidth-0.1.9 webexteamssdk-1.1.1 websockets-8.1 werkzeug-1.0.0 wrapt-1.12.1 yarl-1.4.2 zipp-3.1.0 root@c02085da1f5f:/#インストールできた。

次はrasaのinit。

の前に、作業ディレクトリを移動する。/ 直下でなんかファイルができると気持ち悪いので。

root@c02085da1f5f:/# pwd / root@c02085da1f5f:/# ls -al total 88 drwxr-xr-x 1 root root 4096 Mar 27 08:25 . drwxr-xr-x 1 root root 4096 Mar 27 08:25 .. -rwxr-xr-x 1 root root 0 Mar 27 08:25 .dockerenv drwxr-xr-x 4 root root 128 Mar 27 08:22 app drwxr-xr-x 1 root root 4096 Mar 27 08:33 bin drwxr-xr-x 2 root root 4096 Feb 1 17:09 boot drwxr-xr-x 5 root root 360 Mar 27 08:25 dev drwxr-xr-x 1 root root 4096 Mar 27 08:33 etc drwxr-xr-x 2 root root 4096 Feb 1 17:09 home drwxr-xr-x 1 root root 4096 Mar 27 08:33 lib drwxr-xr-x 2 root root 4096 Feb 24 00:00 lib64 drwxr-xr-x 2 root root 4096 Feb 24 00:00 media drwxr-xr-x 2 root root 4096 Feb 24 00:00 mnt drwxr-xr-x 2 root root 4096 Feb 24 00:00 opt dr-xr-xr-x 228 root root 0 Mar 27 08:25 proc drwx------ 1 root root 4096 Mar 27 08:27 root drwxr-xr-x 3 root root 4096 Feb 24 00:00 run drwxr-xr-x 2 root root 4096 Feb 24 00:00 sbin drwxr-xr-x 2 root root 4096 Feb 24 00:00 srv dr-xr-xr-x 13 root root 0 Mar 27 08:25 sys drwxrwxrwt 1 root root 4096 Mar 27 08:36 tmp drwxr-xr-x 1 root root 4096 Feb 24 00:00 usr drwxr-xr-x 1 root root 4096 Feb 24 00:00 var root@c02085da1f5f:/# cd app/ root@c02085da1f5f:/app# ls -al total 12 drwxr-xr-x 4 root root 128 Mar 27 08:22 . drwxr-xr-x 1 root root 4096 Mar 27 08:25 .. -rw-r--r-- 1 root root 29 Mar 27 08:20 Dockerfile -rw-r--r-- 1 root root 112 Mar 27 08:22 docker-compose.yml root@c02085da1f5f:/app#/app で作業する。

rasa init する

root@c02085da1f5f:/app# rasa init --no-prompt Welcome to Rasa! ? To get started quickly, an initial project will be created. If you need some help, check out the documentation at https://rasa.com/docs/rasa. Created project directory at '/app'. Finished creating project structure. Training an initial model... Training Core model... (なんやかんや) 2020-03-27 08:46:25 INFO rasa.nlu.model - Successfully saved model into '/tmp/tmp4p2k58s6/nlu' NLU model training completed. Your Rasa model is trained and saved at '/app/models/20200327-084527.tar.gz'. If you want to speak to the assistant, run 'rasa shell' at any time inside the project directory. root@c02085da1f5f:/app#init できたっぽい。

ディレクトリ内を見てみる。

root@c02085da1f5f:/app# ls -al total 32 drwxr-xr-x 14 root root 448 Mar 27 08:46 . drwxr-xr-x 1 root root 4096 Mar 27 08:25 .. -rw-r--r-- 1 root root 29 Mar 27 08:20 Dockerfile -rw-r--r-- 1 root root 0 Mar 27 08:36 __init__.py drwxr-xr-x 4 root root 128 Mar 27 08:45 __pycache__ -rw-r--r-- 1 root root 757 Mar 27 08:36 actions.py -rw-r--r-- 1 root root 622 Mar 27 08:36 config.yml -rw-r--r-- 1 root root 938 Mar 27 08:36 credentials.yml drwxr-xr-x 4 root root 128 Mar 27 08:45 data -rw-r--r-- 1 root root 112 Mar 27 08:22 docker-compose.yml -rw-r--r-- 1 root root 549 Mar 27 08:36 domain.yml -rw-r--r-- 1 root root 1456 Mar 27 08:36 endpoints.yml drwxr-xr-x 3 root root 96 Mar 27 08:46 models drwxr-xr-x 3 root root 96 Mar 27 08:45 tests root@c02085da1f5f:/app#なんか色々増えてる。

参考にした記事と同様に、まずは会話してみる。

root@c02085da1f5f:/app# rasa shell 2020-03-27 08:54:07 INFO root - Connecting to channel 'cmdline' which was specified by the '--connector' argument. Any other channels will be ignored. To connect to all given channels, omit the '--connector' argument. 2020-03-27 08:54:07 INFO root - Starting Rasa server on http://localhost:5005 2020-03-27 08:54:08.593814: E tensorflow/stream_executor/cuda/cuda_driver.cc:351] failed call to cuInit: UNKNOWN ERROR (303) Bot loaded. Type a message and press enter (use '/stop' to exit): Your input -> hello Hey! How are you? Your input -> /stop 2020-03-27 08:54:31 INFO root - Killing Sanic server now. root@c02085da1f5f:/app#おお。できてる。

日本語に対応する

https://tech.mof-mof.co.jp/blog/rasa-nlu-japanese.html

次にこの記事に戻って日本語対応してみる。

まずは

data/nlu.mdの一番下にデータを追加してみる。$ vi data/nlu.mddata/nlu.md## intent:restaurant_ja - 渋谷で美味しいイタリアンない? - 和食食べたいんだけど、六本木におすすめある? - 今度麻布行くんだけど、フレンチのお店教えて上記記事だとmecabをやめてspaCyを使っているようなので、mecabを飛ばしてspaCyでやってみる。

config.yml にデフォルト設定があるようなので、一旦全部消して以下を書いてみる。

config.ymlpipeline: # - name: “tokenizer_whitespace” - name: “nlp_spacy” - name: “tokenizer_spacy” - name: “CRFEntityExtractor” - name: “ner_crf” - name: “ner_synonyms” - name: “intent_featurizer_count_vectors” - name: “intent_classifier_tensorflow_embedding”学習させてみる。

root@c02085da1f5f:/app# rasa train nlu The config file 'config.yml' is missing mandatory parameters: 'language'. Add missing parameters to config file and try again. root@c02085da1f5f:/app#config.yml に languageが無いよって。

上記記事だとja_ginzaにしているようなので、端折って config.yml の一番上に ja_ginza を追加してみる。

config.ymllanguage: ja_ginzaもういっかいコマンドを叩いてみる。

root@c02085da1f5f:/app# rasa train nlu Training NLU model... Traceback (most recent call last): File "/usr/local/lib/python3.7/site-packages/rasa/nlu/registry.py", line 173, in get_component_class return class_from_module_path(component_name) File "/usr/local/lib/python3.7/site-packages/rasa/utils/common.py", line 211, in class_from_module_path raise ImportError(f"Cannot retrieve class from path {module_path}.") ImportError: Cannot retrieve class from path “nlp_spacy”. (なんやかんや)nlp_spacyが云々で怒られている。

spaCy入れてないもんね。

spaCy入れてみる。

root@c02085da1f5f:/app# pip install spacy (なんやかんや) Successfully installed blis-0.4.1 catalogue-1.0.0 cymem-2.0.3 murmurhash-1.0.2 plac-1.1.3 preshed-3.0.2 spacy-2.2.4 srsly-1.0.2 thinc-7.4.0 tqdm-4.43.0 wasabi-0.6.0 root@c02085da1f5f:/app#入った。

GiNZAの日本語処理ライブラリ?があるようなので、インストールする。

root@c02085da1f5f:/app# pip install "https://github.com/megagonlabs/ginza/releases/download/latest/ginza-latest.tar.gz" Collecting https://github.com/megagonlabs/ginza/releases/download/latest/ginza-latest.tar.gz (なんやかんや) Successfully built ginza ja-ginza SudachiDict-core Installing collected packages: ja-ginza, sortedcontainers, Cython, dartsclone, SudachiPy, SudachiDict-core, ginza Successfully installed Cython-0.29.16 SudachiDict-core-20190927 SudachiPy-0.4.3 dartsclone-0.9.0 ginza-2.2.1 ja-ginza-2.2.0 sortedcontainers-2.1.0 root@c02085da1f5f:/app#インストールできた。

これで準備できたか?

もう一回コマンドを叩く。

root@c02085da1f5f:/app# rasa train nlu Training NLU model... Traceback (most recent call last): File "/usr/local/lib/python3.7/site-packages/rasa/nlu/registry.py", line 173, in get_component_class return class_from_module_path(component_name) File "/usr/local/lib/python3.7/site-packages/rasa/utils/common.py", line 211, in class_from_module_path raise ImportError(f"Cannot retrieve class from path {module_path}.") ImportError: Cannot retrieve class from path “nlp_spacy”. During handling of the above exception, another exception occurred: Traceback (most recent call last): File "/usr/local/bin/rasa", line 8, in <module> sys.exit(main()) File "/usr/local/lib/python3.7/site-packages/rasa/__main__.py", line 91, in main cmdline_arguments.func(cmdline_arguments) File "/usr/local/lib/python3.7/site-packages/rasa/cli/train.py", line 140, in train_nlu persist_nlu_training_data=args.persist_nlu_data, File "/usr/local/lib/python3.7/site-packages/rasa/train.py", line 414, in train_nlu persist_nlu_training_data, File "uvloop/loop.pyx", line 1456, in uvloop.loop.Loop.run_until_complete File "/usr/local/lib/python3.7/site-packages/rasa/train.py", line 445, in _train_nlu_async persist_nlu_training_data=persist_nlu_training_data, File "/usr/local/lib/python3.7/site-packages/rasa/train.py", line 474, in _train_nlu_with_validated_data persist_nlu_training_data=persist_nlu_training_data, File "/usr/local/lib/python3.7/site-packages/rasa/nlu/train.py", line 74, in train trainer = Trainer(nlu_config, component_builder) File "/usr/local/lib/python3.7/site-packages/rasa/nlu/model.py", line 142, in __init__ components.validate_requirements(cfg.component_names) File "/usr/local/lib/python3.7/site-packages/rasa/nlu/components.py", line 51, in validate_requirements component_class = registry.get_component_class(component_name) File "/usr/local/lib/python3.7/site-packages/rasa/nlu/registry.py", line 199, in get_component_class raise ModuleNotFoundError(exception_message) ModuleNotFoundError: Cannot find class '“nlp_spacy”' from global namespace. Please check that there is no typo in the class name and that you have imported the class into the global namespace. root@c02085da1f5f:/app#なんか怒られた。

Cannot find class '“nlp_spacy”'ってなんだろ。

ModuleNotFoundError: Cannot find class '“nlp_spacy”' from global namespace. Please check that there is no typo in the class name and that you have imported the class into the global namespace.でググってみる。https://github.com/RasaHQ/rasa/blob/master/rasa/nlu/registry.py

このページが一番上に出てきた。

https://github.com/RasaHQ/rasa/blob/master/rasa/nlu/registry.py#L101

old_style_names?"nlp_spacy": "SpacyNLP",こんな感じの対応付けが定義されている。

さっきconfig.ymlに書いたのが、

nlp_spacyだからSpacyNLPに変更してみる。config.ymllanguage: ja_ginza pipeline: # - name: “tokenizer_whitespace” - name: "SpacyNLP" # ←ここを変更 - name: "tokenizer_spacy" - name: "CRFEntityExtractor" - name: "ner_crf" - name: "ner_synonyms" - name: "intent_featurizer_count_vectors" - name: "intent_classifier_tensorflow_embedding"再度コマンドを叩く。

root@c02085da1f5f:/app# rasa train nlu Training NLU model... (なんやかんや) ModuleNotFoundError: Cannot find class '“SpacyNLP”' from global namespace. Please check that there is no typo in the class name and that you have imported the class into the global namespace.

“SpacyNLP”??あ、コピペしたらダブルクオートがおかしいのか。

ダブルクオートを治す。

config.ymllanguage: ja_ginza pipeline: # - name: “tokenizer_whitespace” - name: "nlp_spacy" - name: "tokenizer_spacy" - name: "CRFEntityExtractor" - name: "ner_crf" - name: "ner_synonyms" - name: "intent_featurizer_count_vectors" - name: "intent_classifier_tensorflow_embedding"もういっかいコマンド叩く。

root@c02085da1f5f:/app# rasa train nlu Training NLU model... (なんやかんや) oblib, which can be installed with: pip install joblib. If this warning is raised when loading pickled models, you may need to re-serialize those models with scikit-learn 0.21+. warnings.warn(msg, category=FutureWarning) 2020-03-27 09:15:20 INFO rasa.nlu.model - Successfully saved model into '/tmp/tmpn4xtb3h7/nlu' NLU model training completed. Your Rasa model is trained and saved at '/app/models/nlu-20200327-091520.tar.gz'. root@c02085da1f5f:/app#お、やっと動いた。

rasa shell nluで intent が取れれば成功?root@c02085da1f5f:/app# rasa shell nlu 2020-03-27 09:16:26 INFO rasa.nlu.components - Added 'SpacyNLP' to component cache. Key 'SpacyNLP-ja_ginza'. /usr/local/lib/python3.7/site-packages/sklearn/externals/joblib/__init__.py:15: FutureWarning: sklearn.externals.joblib is deprecated in 0.21 and will be removed in 0.23. Please import this functionality directly from joblib, which can be installed with: pip install joblib. If this warning is raised when loading pickled models, you may need to re-serialize those models with scikit-learn 0.21+. warnings.warn(msg, category=FutureWarning) 2020-03-27 09:16:26.359929: E tensorflow/stream_executor/cuda/cuda_driver.cc:351] failed call to cuInit: UNKNOWN ERROR (303) /usr/local/lib/python3.7/site-packages/rasa/nlu/classifiers/diet_classifier.py:864: FutureWarning: 'EmbeddingIntentClassifier' is deprecated and will be removed in version 2.0. Use 'DIETClassifier' instead. model=model, NLU model loaded. Type a message and press enter to parse it. Next message: 六本木のイタリアン教えて { "intent": { "name": "restaurant_ja", "confidence": 0.48260971903800964 }, "entities": [], "intent_ranking": [ { "name": "restaurant_ja", "confidence": 0.48260971903800964 }, { "name": "affirm", "confidence": 0.1126396581530571 }, { "name": "greet", "confidence": 0.09804855287075043 }, { "name": "goodbye", "confidence": 0.08541827648878098 }, { "name": "mood_great", "confidence": 0.07586738467216492 }, { "name": "deny", "confidence": 0.06578702479600906 }, { "name": "bot_challenge", "confidence": 0.05436018109321594 }, { "name": "mood_unhappy", "confidence": 0.025269268080592155 } ], "text": "六本木のイタリアン教えて" } Next message:お、それっぽい。intentのスコア低いけど、こんなもん?

固有表現もやってみよう。

data/nlu.mdの日本語の箇所を下記のように書き換えて、data/nlu.md## intent:restaurant_ja - [渋谷](location)で美味しい[イタリアン](restaurant_type)ない? - [和食](restaurant_type)食べたいんだけど、[六本木](location)におすすめある? - 今度[麻布](location)行くんだけど、[フレンチ](restaurant_type)のお店教えて学習させて、

root@c02085da1f5f:/app# rasa train nlu Training NLU model... (なんやかんや) 2020-03-27 13:46:37 INFO rasa.nlu.model - Finished training component. /usr/local/lib/python3.7/site-packages/sklearn/externals/joblib/__init__.py:15: FutureWarning: sklearn.externals.joblib is deprecated in 0.21 and will be removed in 0.23. Please import this functionality directly from joblib, which can be installed with: pip install joblib. If this warning is raised when loading pickled models, you may need to re-serialize those models with scikit-learn 0.21+. warnings.warn(msg, category=FutureWarning) 2020-03-27 13:46:37 INFO rasa.nlu.model - Successfully saved model into '/tmp/tmpy7tqyrsb/nlu' NLU model training completed. Your Rasa model is trained and saved at '/app/models/nlu-20200327-134637.tar.gz'. root@c02085da1f5f:/app#shell を叩いてみる。

root@c02085da1f5f:/app# rasa shell nlu 2020-03-27 13:47:07 INFO rasa.nlu.components - Added 'SpacyNLP' to component cache. Key 'SpacyNLP-ja_ginza'. /usr/local/lib/python3.7/site-packages/sklearn/externals/joblib/__init__.py:15: FutureWarning: sklearn.externals.joblib is deprecated in 0.21 and will be removed in 0.23. Please import this functionality directly from joblib, which can be installed with: pip install joblib. If this warning is raised when loading pickled models, you may need to re-serialize those models with scikit-learn 0.21+. warnings.warn(msg, category=FutureWarning) 2020-03-27 13:47:07.924760: E tensorflow/stream_executor/cuda/cuda_driver.cc:351] failed call to cuInit: UNKNOWN ERROR (303) /usr/local/lib/python3.7/site-packages/rasa/nlu/classifiers/diet_classifier.py:864: FutureWarning: 'EmbeddingIntentClassifier' is deprecated and will be removed in version 2.0. Use 'DIETClassifier' instead. model=model, NLU model loaded. Type a message and press enter to parse it. Next message: 渋谷で美味しいイタリアンない? { "intent": { "name": "restaurant_ja", "confidence": 0.9823814034461975 }, "entities": [ { "start": 0, "end": 2, "value": "渋谷", "entity": "location", "confidence": 0.7429793877231764, "extractor": "CRFEntityExtractor" }, { "start": 7, "end": 12, "value": "イタリアン", "entity": "restaurant_type", "confidence": 0.7588623133724827, "extractor": "CRFEntityExtractor" }, { "start": 0, "end": 2, "value": "渋谷", "entity": "location", "confidence": 0.7429793877231764, "extractor": "CRFEntityExtractor" }, { "start": 7, "end": 12, "value": "イタリアン", "entity": "restaurant_type", "confidence": 0.7588623133724827, "extractor": "CRFEntityExtractor" } ], "intent_ranking": [ { "name": "restaurant_ja", "confidence": 0.9823814034461975 }, { "name": "mood_great", "confidence": 0.008284788578748703 }, { "name": "deny", "confidence": 0.006644146051257849 }, { "name": "greet", "confidence": 0.001571052591316402 }, { "name": "bot_challenge", "confidence": 0.0006475948612205684 }, { "name": "affirm", "confidence": 0.00034828390926122665 }, { "name": "mood_unhappy", "confidence": 8.46567636472173e-05 }, { "name": "goodbye", "confidence": 3.805106462095864e-05 } ], "text": "渋谷で美味しいイタリアンない?" } Next message:おお。記事みたいな出力になった。

記事とは違って日本語は文字化けしてないけど。

環境ができて動くところまで見れたので、今回はここまで。

今後は教師データを増やす方法を考える。追記

ここまでの成果として、pip で install したライブラリを requirements.txt にして、build したら勝手にインストールされるように Dockerfile に処理を追記しておいた。

requirements.txtrasa==1.9.2 spacy==2.2.4FROM python:3.7-slim-stretch RUN apt-get update -q -y && \ apt-get install -q -y \ build-essential ADD ./requirements.txt requirements.txt RUN pip install -r requirements.txt RUN pip install "https://github.com/megagonlabs/ginza/releases/download/latest/ginza-latest.tar.gz" ADD . /app WORKDIR /appんで、build して

$ docker-compose build動かす

$ docker-compose run --rm rasa bash root@56ff2c2f2f38:/app#追記2

github で公開した

https://github.com/booink/rasa-trial

追記3

ginzaのインストールはpip経由で(3.0から)できるようになったようなので、requirements.txtにginzaを追記してDockerfileから該当箇所を削除した。

https://github.com/booink/rasa-trial/commit/eb8e020d70ad8d92e29c628008d550d214bcc14c

- 投稿日:2020-03-27T22:26:17+09:00

1次元移流方程式を有限要素法で解いてみる.py

1次元移流方程式をSUPG(Streamline Upwind/Petrov-Galerkin)法に基づく安定化有限要素法によって解いてみます.

言語はPythonを用います.使用したバージョンは Python 3.6.1です.参考文献:

計算力学(第2版)-有限要素法の基礎(森北出版)

第3版 有限要素法による流れのシミュレーション OpenMPに基づくFortranソースコード付(丸善出版)1次元移流方程式

1次元移流方程式は以下のような1階の偏微分方程式で表されます.

\cfrac{\partial f}{\partial t} + u\ \cfrac{\partial f}{\partial x} = 0ここで,$f$ は移流される物理量(例えば濃度),$u$ は移流速度です.

安定化有限要素法による離散化

解析領域 $\Omega$ を$M$ 個の1次要素の要素領域 $\Omega_e$に分割すると以下の離散化方程式が得られます.

\int_\Omega \omega\ \cfrac{\partial f}{\partial t}\ d\Omega\ + \int_\Omega \omega\ u\ \cfrac{\partial f}{\partial x}\ d\Omega\ + \sum_{e = 1}^M\int_{\Omega_e} \tau_e\ u\ \cfrac{\partial \omega}{\partial x}\left(\cfrac{\partial f}{\partial t}\ + u\ \cfrac{\partial f}{\partial x}\right)\ d\Omega = 0ここで,$\omega$ は重み関数,$\tau_e$ は安定化パラメータであり,一般的に非定常問題の場合は要素長 $h_e$ と時間刻み$\Delta t$ を用いて

\tau_e = \left(\left( \cfrac{2}{\Delta t}\right)^2 + \left(\cfrac{2|u|}{h_e}\right)^2\ \right)^{-\frac{1}{2}}と表されます.ある要素 $e$ に着目すると

\int_{\Omega_e} \omega\ \cfrac{\partial f}{\partial t}\ d\Omega\ + \int_{\Omega_e} \omega\ u\ \cfrac{\partial f}{\partial x}\ d\Omega\ + \int_{\Omega_e} \tau_e\ u\ \cfrac{\partial \omega}{\partial x}\left(\cfrac{\partial f}{\partial t}\ + u\ \cfrac{\partial f}{\partial x}\right)\ d\Omega = 0が得られます.2節点1次要素を用いて要素内の $\omega$, $f$ 及び $u$ をそれぞれ

\begin{align} \omega(x) &= \cfrac{x_2^e - x}{h_e}\ \omega_1^e + \cfrac{x - x_1^e}{h_e}\ \omega_2^e\\ &= \begin{pmatrix} N_1^e & N_2^e \end{pmatrix} \begin{pmatrix} \omega_1^e\\ \omega_2^e\\ \end{pmatrix} = {\bf N}_e{\bf \omega}_e, \end{align}\begin{align} f(x) &= \cfrac{x_2^e - x}{h_e}\ f_1^e + \cfrac{x - x_1^e}{h_e}\ f_2^e\\ &= \begin{pmatrix} N_1^e & N_2^e \end{pmatrix} \begin{pmatrix} f_1^e\\ f_2^e\\ \end{pmatrix} = {\bf N}_e{\bf f}_e, \end{align}\begin{align} u(x) &= \cfrac{x_2^e - x}{h_e}\ u_1^e + \cfrac{x - x_1^e}{h_e}\ u_2^e\\ &= {\begin{pmatrix} N_1^e & N_2^e \end{pmatrix}} \begin{pmatrix} u_1^e\\ u_2^e\\ \end{pmatrix} = {\bf N}_e{\bf u}_e \end{align}と補間します.同様に $f$ の時間微分も

\begin{align} \dot{f}(x) &= \cfrac{x_2^e - x}{h_e}\ \dot{f}_1^e + \cfrac{x - x_1^e}{h_e}\ \dot{f}_2^e\\ &= {\begin{pmatrix} N_1^e & N_2^e \end{pmatrix}} \begin{pmatrix} \dot{f}_1^e\\ \dot{f}_2^e\\ \end{pmatrix} = {\bf N}_e\dot{{\bf f}}_e \end{align}と補間します.これら代入すると以下の式が得られます.

\int_{\Omega_e} {\bf N}_e{\bf \omega}_e {\bf N}_e\dot{\bf f}_e\ d\Omega\ + \int_{\Omega_e} {\bf N}_e{\bf \omega}_e\ {\bf N}_e{\bf u}_e\cfrac{\partial {\bf N}_e}{\partial x}\ {\bf f}_e\ d\Omega\ + \int_{\Omega_e} \tau_e\ {\bf N}_e{\bf u}_e\cfrac{\partial {\bf N}_e}{\partial x}{\bf \omega}_e\left({\bf N}_e\dot{{\bf f}}_e\ + {\bf N}_e{\bf u}_e\cfrac{\partial {\bf N}_e}{\partial x}{\bf f}_e\right)\ d\Omega = 0形状関数 $N$ の空間微分は

\begin{align} \cfrac{\partial {\bf N}_e}{\partial x} &= {\begin{pmatrix} \cfrac{\partial N_1^e}{\partial x} & \cfrac{\partial N_2^e}{\partial x} \end{pmatrix}} = {\begin{pmatrix} -\cfrac{1}{h_e} & \cfrac{1}{h_e} \end{pmatrix}} \end{align}となり,要素内では一定値となります.

${\bf N}_ e\omega_e = ({\bf N}_ e \omega_e)^T = \omega_e^T{\bf N}_ e^T$ 等を用いて式変形していくと\omega_e^T\left(\int_{\Omega_e} {\bf N}_e^T{\bf N}_e\ d\Omega\ \dot{\bf f}_e\ + \int_{\Omega_e} {\bf N}_e^T\ {\bf N}_e{\bf u}_e\ \cfrac{\partial {\bf N}_e}{\partial x}\ d\Omega\ {\bf f}_e\ + \int_{\Omega_e} \tau_e\ \left(\cfrac{\partial {\bf N}_e}{\partial x}\right)^T{\bf u}_e^T{\bf N}_e^T{\bf N}_e\ d\Omega\ \dot{{\bf f}}_e\ + \int_{\Omega_e} \tau_e\ \left(\cfrac{\partial {\bf N}_e}{\partial x}\right)^T{\bf u}_e^T{\bf N}_e^T{\bf N}_e\ d\Omega\ {\bf u}_e\cfrac{\partial {\bf N}_e}{\partial x}\ {{\bf f}}_e\right)= 0となります.重み関数は任意に選んだ定数なので,有限要素方程式は以下のようになります.

\left({\bf M}_e + {\bf M}_{\delta e}\right)\ \dot{{\bf f}}_e + \left({\bf S}_e + {\bf S}_{\delta e}\right)\ {\bf f}_e = 0${\bf M}_ e$ は質量行列,${\bf S}_ e$ は移流行列,${\bf M}_ {\delta e}$, ${\bf S}_ {\delta e}$ はそれぞれSUPG項から生じる質量行列と移流行列です.

これらの行列は線座標を用いて求めることが可能であり,それぞれ{\bf M}_e = \int_{\Omega_e} {\bf N}_e^T{\bf N}_e\ d\Omega = \cfrac{h_e}{6} \begin{pmatrix} 2 & 1\\ 1 & 2 \end{pmatrix},\begin{align} {\bf A}_e &= \int_{\Omega_e} {\bf N}_e^T\ {\bf N}_e{\bf u}_e\cfrac{\partial {\bf N}_e}{\partial x}\ d\Omega\\ &= \int_{\Omega_e} {\bf N}_e^T\ {\bf N}_e\ d\Omega\ {\bf u}_e\cfrac{\partial {\bf N}_e}{\partial x}\\ &= \cfrac{h_e}{6} \begin{pmatrix} 2 & 1\\ 1 & 2 \end{pmatrix} \begin{pmatrix} u_1^e\\ u_2^e \end{pmatrix} \begin{pmatrix} -\cfrac{1}{h_e} & \cfrac{1}{h_e} \end{pmatrix}\\ &= \cfrac{1}{6} \begin{pmatrix} 2 & 1\\ 1 & 2 \end{pmatrix} \begin{pmatrix} -u_1^e & u_1^e\\ -u_2^e & u_2^e \end{pmatrix}\\ &= \cfrac{1}{6} \begin{pmatrix} -2u_1^e - u_2^e & 2u_1^e + u_2^e\\ -u_1^e - 2u_2^e & u_1^e + 2u_2^e \end{pmatrix}, \end{align}\begin{align} {\bf M}_{\delta e} &= \int_{\Omega_e} \tau_e\ \left(\cfrac{\partial {\bf N}_e}{\partial x}\right)^T{\bf u}_e^T{\bf N}_e^T{\bf N}_e\ d\Omega\\ &= \tau_e\ \left(\cfrac{\partial {\bf N}_e}{\partial x}\right)^T{\bf u}_e^T\ \int_{\Omega_e} {\bf N}_e^T{\bf N}_e\ d\Omega\\ &= \tau_e \begin{pmatrix} -\cfrac{1}{h_e}\\ \cfrac{1}{h_e} \end{pmatrix} \begin{pmatrix} u_1^e & u_2^e \end{pmatrix} \cfrac{h_e}{6} \begin{pmatrix} 2 & 1\\ 1 & 2 \end{pmatrix}\\ &= \cfrac{\tau_e}{6} \begin{pmatrix} -2u_1^e - u_2^e & -u_1^e - 2u_2^e\\ 2u_1^e + u_2^e & u_1^e + 2u_2^e \end{pmatrix}, \end{align}\begin{align} {\bf A}_{\delta e} &= \int_{\Omega_e} \tau_e\ \left(\cfrac{\partial {\bf N}_e}{\partial x}\right)^T{\bf u}_e^T{\bf N}_e^T{\bf N}_e\ d\Omega\ {\bf u}_e\cfrac{\partial {\bf N}_e}{\partial x}\\ &= \tau_e\ \left(\cfrac{\partial {\bf N}_e}{\partial x}\right)^T{\bf u}_e^T \int_{\Omega_e} {\bf N}_e^T{\bf N}_e\ d\Omega\ {\bf u}_e\cfrac{\partial {\bf N}_e}{\partial x}\\ &=\tau_e \begin{pmatrix} -\cfrac{1}{h_e}\\ \cfrac{1}{h_e} \end{pmatrix} \begin{pmatrix} u_1^e & u_2^e \end{pmatrix} \cfrac{h_e}{6} \begin{pmatrix} 2 & 1\\ 1 & 2 \end{pmatrix} \begin{pmatrix} u_1^e\\ u_2^e \end{pmatrix} \begin{pmatrix} -\cfrac{1}{h_e} & \cfrac{1}{h_e} \end{pmatrix}\\ &= \cfrac{\tau_e}{3h_e}\left({u_1^e}^2 + u_1^e u_2^e + {u_2^e}^2 \right) \begin{pmatrix} 1 & -1\\ -1 & 1 \end{pmatrix} \end{align}となります.これらを使って全体の有限要素方程式

\left({\bf M} + {\bf M}_{\delta}\right)\ \dot{{\bf f}} + \left({\bf S} + {\bf S}_{\delta}\right)\ {\bf f} = 0を組み立てていきます.時間方向の離散化にクランク・ニコルソン法を用いると

\left({\bf M} + {\bf M}_{\delta}\right)\ \cfrac{{\bf f}^{n+1} - {\bf f}^n}{\Delta t} + \left({\bf S} + {\bf S}_{\delta}\right)\ \cfrac{1}{2}\left({\bf f}^{n+1} + {\bf f}^n\right) = 0が得られます.$n$ は時間ステップです.さらに変形すると

\left(\cfrac{1}{\Delta t}\left({\bf M} + {\bf M}_{\delta}\right) + \cfrac{1}{2} \left({\bf S} + {\bf S}_{\delta}\right)\right) {\bf f}^{n+1} = \left(\cfrac{1}{\Delta t}\left({\bf M} + {\bf M}_{\delta}\right) - \cfrac{1}{2} \left({\bf S} + {\bf S}_{\delta}\right)\right) {\bf f}^nとなります.この式をよく見てみると,左辺が未知量,右辺は既知量で,${\bf A}{\bf x} = {\bf b}$ という連立1次方程式の形をしていることが分かります.つまり,この連立1次方程式を解けば次の時刻の物理量が得られるという事です.

Pythonによる実装

各要素ごとに質量・移流行列を求めて全体行列に足しこんでいきます.コードを以下に示します.なお,上記の式を愚直にコーディングしただけであり,連立1次方程式を解くためにNumPyのlinalg.solveを用いています.本来は高速化のために三重対角行列アルゴリズムや反復法などを用いるべきですが,今回は簡単のためlinalg.solveを用いています.

解析領域は$0 \le x \le 2$ とし,境界条件は $f(x = 0, t) = f(x = 2, t) = 0$ というディリクレ境界条件を与えます.

初期条件は$0 \le x \le 1$ で $f(x, t = 0) = \sin(\pi x)$,それ以外で $f(x, t = 0) = 0$ とします.移流速度は全領域で一様で $u = 1.0$ を与えます.実装やアニメーションの作成には以下のサイトを参考にしました.

【NumPy】連立方程式を解く numpy.linalg.solve

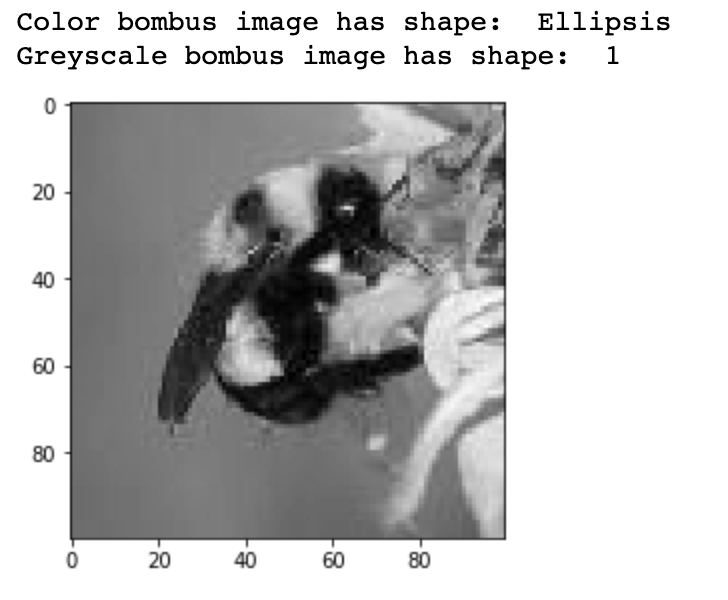

Pythonで波動方程式の数値計算 & 結果のアニメーション1d_advection.pyimport math import numpy as np import matplotlib.pyplot as plt import matplotlib.animation as animation # 各種定数の設定 dt = 0.005 # 時間刻み xmin = 0.0 xmax = 2.0 N = 200 dx = (xmax - xmin)/N # 空間刻み U = 1.0 # 移流速度 M = 200 # 変数の初期化 f = np.array([[0.0]*(N + 1) for i in range(M + 1)]) u = np.zeros([N + 1]) # マトリクスの初期化 A = np.array([[0.0]*(N + 1) for i in range(N + 1)]) b = np.array([0.0]*(N + 1)) # 初期条件 for i in range(N + 1): u[i] = U if i*dx <= 1.0: f[0, i] = math.sin(math.pi*i*dx) else: f[0, i] = 0.0 for ti in range(0, M): A.fill(0.0) b.fill(0.0) for i in range(N): u1 = u[i] u2 = u[i + 1] tau = 1.0/math.sqrt((2.0/dt)**2 + (2.0*U/dx)**2) # 質量行列 A[i ,i ] = A[i ,i ] + 1.0/dt*2.0/6.0*dx A[i ,i + 1] = A[i ,i + 1] + 1.0/dt*1.0/6.0*dx A[i + 1,i ] = A[i + 1,i ] + 1.0/dt*1.0/6.0*dx A[i + 1,i + 1] = A[i + 1,i + 1] + 1.0/dt*2.0/6.0*dx # 質量行列(SUPG) A[i ,i ] = A[i ,i ] + tau/dt/6.0*(-2.0*u1 - u2) A[i ,i + 1] = A[i ,i + 1] + tau/dt/6.0*(- u1 - 2.0*u2) A[i + 1,i ] = A[i + 1,i ] + tau/dt/6.0*( 2.0*u1 + u2) A[i + 1,i + 1] = A[i + 1,i + 1] + tau/dt/6.0*( u1 + 2.0*u2) # 移流行列 A[i ,i ] = A[i ,i ] + 0.5/6.0*(-2.0*u1 - u2) A[i ,i + 1] = A[i ,i + 1] + 0.5/6.0*( 2.0*u1 + u2) A[i + 1,i ] = A[i + 1,i ] + 0.5/6.0*(- u1 - 2.0*u2) A[i + 1,i + 1] = A[i + 1,i + 1] + 0.5/6.0*( u1 + 2.0*u2) # 移流行列(SUPG) A[i ,i ] = A[i ,i ] + 0.5*tau/3.0/dx*(u1**2 + u1*u2 + u2**2) A[i ,i + 1] = A[i ,i + 1] - 0.5*tau/3.0/dx*(u1**2 + u1*u2 + u2**2) A[i + 1,i ] = A[i + 1,i ] - 0.5*tau/3.0/dx*(u1**2 + u1*u2 + u2**2) A[i + 1,i + 1] = A[i + 1,i + 1] + 0.5*tau/3.0/dx*(u1**2 + u1*u2 + u2**2) for i in range(N): f1 = f[ti, i] f2 = f[ti, i + 1] u1 = u[i] u2 = u[i + 1] tau = 1.0/math.sqrt((2.0/dt)**2 + (2.0*U/dx)**2) # 質量行列 b[i ] = b[i ] + 1.0/dt*dx/6.0*(2.0*f1 + f2) b[i + 1] = b[i + 1] + 1.0/dt*dx/6.0*( f1 + 2.0*f2) # 質量行列(SUPG) b[i ] = b[i ] + tau/dt/6.0*((-2.0*u1 - u2)*f1 + (-u1 - 2.0*u2)*f2) b[i + 1] = b[i + 1] + tau/dt/6.0*(( 2.0*u1 + u2)*f1 + ( u1 + 2.0*u2)*f2) # 移流行列 b[i ] = b[i ] - 0.5/6.0*((-2.0*u1 - u2)*f1 + (2.0*u1 + u2)*f2) b[i + 1] = b[i + 1] - 0.5/6.0*((- u1 - 2.0*u2)*f1 + ( u1 + 2.0*u2)*f2) # 移流行列(SUPG) b[i ] = b[i ] - 0.5*tau/dx/3.0*(u1**2 + u1*u2 + u2**2)*( f1 - f2) b[i + 1] = b[i + 1] - 0.5*tau/dx/3.0*(u1**2 + u1*u2 + u2**2)*(-f1 + f2) # 境界条件 for i in range(N + 1): A[0, i] = 0.0 A[N, i] = 0.0 A[0, 0] = 1.0 A[N, N] = 1.0 b[0] = 0.0 b[N] = 0.0 f[ti + 1,] = np.linalg.solve(A, b) x = np.linspace(xmin, xmax, N + 1) # x軸の設定 fig = plt.figure(figsize=(6,4)) ax = fig.add_subplot(1,1,1) # アニメ更新用の関数 def update_func(i): # 前のフレームで描画されたグラフを消去 ax.clear() ax.plot(x, f[i, :], color='blue') ax.scatter(x, f[i, :], color='blue') # 軸の設定 ax.set_ylim(-0.1, 1.1) # 軸ラベルの設定 ax.set_xlabel('x', fontsize=12) ax.set_ylabel('f', fontsize=12) # サブプロットタイトルの設定 ax.set_title('Time: ' + '{:.2f}'.format(dt*i)) ani = animation.FuncAnimation(fig, update_func, frames=M, interval=100, repeat=True) # アニメーションの保存 #ani.save('1d_advection.gif', writer='imagemagick') # 表示 plt.show()計算結果

若干のアンダーシュートが見られますが,サイン波が移流しているのが確認できました.

- 投稿日:2020-03-27T22:13:42+09:00

カタカナから母音のカナに変換する(python)

概要

「コンニチハ->オンイイア」みたいに、カタカナ文字列を入力したら、その母音を返す関数を作りました。

変換ルール

「ン」「ッ」はそのままにする(例:ルンパッパ -> ウンアッア)

「ー」(長音)は直前の母音と同一にする(例:コーラ -> オオア)

「ゥ」は直前のカナが「ト」「ド」の場合、それと合わせて一つの文字とみなし、大文字と同じく扱う(例:ドゥッキ -> ウッイ、ゥアア -> ウアア)

「ャ」「ェ」「ョ」は直前がカナがイ段の場合、直前のカナと合わせて一つの文字とみなし、それ以外の場合は大文字と同じく扱う。(例:キャタツ -> アアウ、キェェ -> エエ)

「ュ」は直前のカナがイ段、「テ」「デ」の場合、それと合わせて一つのカナとみなし、それ以外の場合は大文字と同じく扱う(例:チュール -> ウウウ、デュワー -> ウアア)

「ヮ」「ァ」「ェ」「ォ」は直前のカナがウ段の場合、それと合わせて一つのカナとみなし、それ以外の場合は大文字と同じく扱う。(例:ウェーイ -> エエイ)

「ィ」は直前のカナがウ段、「テ」「デ」の場合、それと合わせて一つのカナとみなし、それ以外の場合は大文字と同じく扱う(例:レモンティー -> エオンイイ、ィエア -> イエア)

カタカナ以外の文字はそのままにする。環境

Google Colaboratory(2020年3月27日時点)およびmacOS Catalina, Python3.8.0での実行を確認しています。

コード

def kana2vowel(text): #大文字とゥの変換リスト large_tone = { 'ア' :'ア', 'イ' :'イ', 'ウ' :'ウ', 'エ' :'エ', 'オ' :'オ', 'ゥ': 'ウ', 'ヴ': 'ウ', 'カ' :'ア', 'キ' :'イ', 'ク' :'ウ', 'ケ' :'エ', 'コ' :'オ', 'サ' :'ア', 'シ' :'イ', 'ス' :'ウ', 'セ' :'エ', 'ソ' :'オ', 'タ' :'ア', 'チ' :'イ', 'ツ' :'ウ', 'テ' :'エ', 'ト' :'オ', 'ナ' :'ア', 'ニ' :'イ', 'ヌ' :'ウ', 'ネ' :'エ', 'ノ' :'オ', 'ハ' :'ア', 'ヒ' :'イ', 'フ' :'ウ', 'ヘ' :'エ', 'ホ' :'オ', 'マ' :'ア', 'ミ' :'イ', 'ム' :'ウ', 'メ' :'エ', 'モ' :'オ', 'ヤ' :'ア', 'ユ' :'ウ', 'ヨ' :'オ', 'ラ' :'ア', 'リ' :'イ', 'ル' :'ウ', 'レ' :'エ', 'ロ' :'オ', 'ワ' :'ア', 'ヲ' :'オ', 'ン' :'ン', 'ヴ' :'ウ', 'ガ' :'ア', 'ギ' :'イ', 'グ' :'ウ', 'ゲ' :'エ', 'ゴ' :'オ', 'ザ' :'ア', 'ジ' :'イ', 'ズ' :'ウ', 'ゼ' :'エ', 'ゾ' :'オ', 'ダ' :'ア', 'ヂ' :'イ', 'ヅ' :'ウ', 'デ' :'エ', 'ド' :'オ', 'バ' :'ア', 'ビ' :'イ', 'ブ' :'ウ', 'ベ' :'エ', 'ボ' :'オ', 'パ' :'ア', 'ピ' :'イ', 'プ' :'ウ', 'ペ' :'エ', 'ポ' :'オ' } #ト/ド+'ゥ'をウに変換 for k in 'トド': while k+'ゥ' in text: text = text.replace(k+'ゥ','ウ') #テ/デ+ィ/ュをイ/ウに変換 for k in 'テデ': for k2,v in zip('ィュ','イウ'): while k+k2 in text: text = text.replace(k+k2,v) #大文字とゥを母音に変換 text = list(text) for i, v in enumerate(text): if v in large_tone: text[i] = large_tone[v] text = ''.join(text) #ウーをウウに変換 while 'ウー' in text: text = text.replace('ウー','ウウ') #ウ+ヮ/ァ/ィ/ェ/ォを母音に変換 for k,v in zip('ヮァィェォ','アアイエオ'): text = text.replace('ウ'+k,v) #イー/ィーをイイ/ィイに変換 for k in 'イィ': while k+'ー' in text: text = text.replace(k+'ー',k+'イ') #イ/ィ+ャ/ュ/ェ/ョを母音に変換 for k,v in zip('ャュェョ','アウエオ'): text = text.replace('イ'+k, v).replace('ィ'+k, v) #残った小文字を母音に変換 for k,v in zip('ヮァィェォャュョ','アアイエオアウオ'): text = text.replace(k,v) #ー(長音)を母音に変換する for k in 'アイウエオ': while k+'ー' in text: text = text.replace(k+'ー',k+k) return text

- 投稿日:2020-03-27T21:55:16+09:00

pythonでLDAPにデータの追加取得をする(WriterとReader編)

はじめに

前回はLDAPの追加と取得を行いました。今回は、WriterとReaderを使用した追加と取得の方法をまとめます。

環境

- python:3.6.5

- ldap3:2.7

- イメージ:osixia/openldap

LDAP操作

Readerを使用したLDAPの読み込み

ldap3には色々な機能を持ったReaderクラスがあります。それを使用してLDAPの情報を取得します。Readerにはコネクションとオブジェクトとcn(検索パス)が必要になります。例は基本的に上から順に続きものとして記載しています。

オブジェクトの生成

オブジェクトはObjectDefクラスに対象のオブジェクト名とコネクションを渡して生成します。今回は、cnの値を取りたいため

inetOrgPersonを指定します。ouを取得したいときはorganizationalUnitなど取得したい対象を指定します。main.pyfrom ldap3 import Server, Connection, ObjectDef, Reader server = Server('localhost') conn = Connection(server, 'cn=admin,dc=sample-ldap', password='LdapPass') result = conn.bind() # inetOrgPersonのオブジェクト生成 obj_cn_name = ObjectDef('inetOrgPerson', conn)Readerの生成

先ほど生成したオブジェクトとコネクション、検索パスを与えてReaderを生成します。この時に与える検索パスにより、どの階層から情報を取得できるかを指定できます。ここではReaderの生成だけで検索していないので値は入っていません。

main.py# リーダーの生成 data_reader = Reader(conn, obj_cn_name, 'ou=sample-unit,dc=sample-component,dc=sample-ldap')LDAPの値の取得

LDAPの値の配下をリストで取得

リーダーの

search()を使用することでLDAP値のリストを取得することができます。main.py# ここで検索をする data = data_reader.search() # 全アイテムが取れる print(data)結果

[DN: cn=sample-name,ou=sample-unit,dc=sample-component,dc=sample-ldap - STATUS: Read - READ TIME: 2020-03-27T20:50:15.470086 cn: sample-name objectClass: inetOrgPerson sn: sample1 sample2 st: test2 , DN: cn=sample-name1,ou=sample-unit,dc=sample-component,dc=sample-ldap - STATUS: Read - READ TIME: 2020-03-27T20:50:15.478084 cn: sample-name1 objectClass: inetOrgPerson sn: sample ]結果を見るとReaderに指定した

ou=sample-unit,dc=sample-component,dc=sample-ldap以下のcnが全て取得できていることがわかります。さらにそれぞれの属性値であるsnとstが取得できています。属性による検索データの取得

search()に属性の文字列を入れて属性値のあるデータを取得します。例ではstを与えており、LDAPの情報は先ほどと同じなのでcn: sample-nameが取れるはずです。main.py# 検索条件を指定する data = data_reader.search('st') print(data)結果

DN: cn=sample-name,ou=sample-unit,dc=sample-component,dc=sample-ldap - STATUS: Read - READ TIME: 2020-03-27T20:50:15.470086 cn: sample-name objectClass: inetOrgPerson sn: sample1 sample2 st: test2結果を見ると予想した通りsample-nameのcnが取れました。

json形式で取得する

リーダーの

entry_to_json()を使用することでLDAPの値をjson形式の文字列に変換して取得できる機能があります。main.py# json形式で取得できる json_str = data[0].entry_to_json() print(json_str) print(type(json_str))結果

{ "attributes": { "st": [ "test2" ] }, "dn": "cn=sample-name,ou=sample-unit,dc=sample-component,dc=sample-ldap" } <class 'str'>Dict形式で取得する

リーダーの

entry_attributes_as_dictを使用することでLDAPの値をDict形式に変換して取得できる機能があります。main.pyldap_dict = data[0].entry_attributes_as_dict print(ldap_dict) print(type(ldap_dict))結果

{'st': ['test2']} <class 'dict'>cnをパスにしてcnを1つ取得する

cnを指定することでその1つのcnのみ情報を取得することができます。

main.py# cnをパスにすれば一個だけとれる data_reader = Reader(conn, obj_cn_name, 'cn=sample-name,ou=sample-unit,dc=sample-component,dc=sample-ldap') data = data_reader.search() print(data)結果

[DN: cn=sample-name,ou=sample-unit,dc=sample-component,dc=sample-ldap - STATUS: Read - READ TIME: 2020-03-27T21:16:17.284094 cn: sample-name objectClass: inetOrgPerson sn: sample1 sample2 st: test2 ]Writerを使用したLDAPの書き込み

ldap3には色々な機能を持ったWriterクラスを使用してLDAPの情報を書き込むことができます。WriterにはReaderを利用して生成することができます。

Writerの生成・書き込み

Writerの

from_cursor()にLDAPの値を取得したReaderを与えてWriterを生成します。

生成したWriterの変数に値を入れてcommit()することで値を書き込みます。main.pyfrom ldap3 import Server, Connection, ObjectDef, Reader, Writer server = Server('localhost') conn = Connection(server, 'cn=admin,dc=sample-ldap', password='LdapPass') result = conn.bind() # readerを使った取得 obj_cn_name = ObjectDef('inetOrgPerson', conn) data_reader = Reader(conn, obj_cn_name, 'cn=sample-name,ou=sample-unit,dc=sample-component,dc=sample-ldap') data = data_reader.search() # 更新前に表示する print(data[0]) # writerに読み込ませる data_writer = Writer.from_cursor(data_reader) # writer経由で値を入れる data_writer[0].sn = 'sample10' data_writer[0].sn += 'sample20' data_writer[0].st = 'test10' # 変更結果の反映 data_writer.commit() # 更新後に表示する data_reader2 = Reader(conn, obj_cn_name, 'cn=sample-name,ou=sample-unit,dc=sample-component,dc=sample-ldap') data2 = data_reader2.search() print(data2[0])結果

DN: cn=sample-name,ou=sample-unit,dc=sample-component,dc=sample-ldap - STATUS: Read - READ TIME: 2020-03-27T21:36:03.493031 cn: sample-name objectClass: inetOrgPerson sn: sample1 sample2 st: test1 DN: cn=sample-name,ou=sample-unit,dc=sample-component,dc=sample-ldap - STATUS: Read - READ TIME: 2020-03-27T21:36:03.686030 cn: sample-name objectClass: inetOrgPerson sn: sample10 sample20 st: test10指定したように値が変わっていることがわかります。

おわりに

LDAPのReaderとWriterを使用したLDAPの取得・変更・追加についてまとめました。ReaderとWriterを使用することでLDAPの扱い方が少し容易になった気がします。そのおかげでRDBの代わりにLDAPを使用するということが現実的になってきました。今回は極力簡単にするために構成を考えずにべたでソースを書いていきましたがもう少し工夫することでさらにソースが便利になるのではないかと思っています。

- 投稿日:2020-03-27T20:47:40+09:00

多次元リスト(配列)を一次元に直す

空のリスト(配列)を新しく作成し、元の要素を一つずつコピーする。

pythonの場合

test.py# coding: utf-8 animal_list = ["イヌ", ["ペルシャ", "マンチカン", "スコティッシュフォールド"], "ヒト", ["ハムスター, カピバラ"]]; new_list = [] for animal in animal_list: if type(animal) == list: new_list.extend(animal) else: new_list.append(animal) print(new_list)

js(gas)の場合

test.gsfunction make_array() { var array = ["イヌ", ["ペルシャ", "マンチカン", "スコティッシュフォールド"], "ヒト", ["ハムスター, カピバラ"]]; var new_array = []; for (var i = 0; i <= array.length - 1; i++) { if (typeof(array[i]) == "object") { array[i].map(function(text) { new_array.push(text) }); } else { new_array.push(array[i]); } } Logger.log(new_array); }

<メモ>

・リストは可変(大きさを決める必要がない)に対し、配列は不変。(宣言時に大きさを決める必要がある)

・jsでは配列の大きさを決める必要がない?

- 投稿日:2020-03-27T19:46:56+09:00

【python】出力するデータのファイル名をユニークにする方法(年月日時秒を使う)

【python】出力するデータのファイル名をユニークにする方法(年月日時秒を使う)

pandasモジュールのto_csvメソッドでファイル名を指定して出力すると、上書きされて古いファイルがなくなってしまう。

ファイル名に実行した年月日時秒を含めることで、個別に出力し上書きを防ぐ方法。

やり方

以下のモジュールとメソッドを使用

①datetimeモジュール

②nowメソッド

③strftimeメソッド

④format関数

実例

コードimport datetime as dt now = dt.datetime.now() time = now.strftime('%Y%m%d-%H%M%S') df.to_csv('~/desktop/output_{}.csv'.format(time), index = False, encoding = 'utf_8_sig')

実行するたびに個別のファイルが生成される。

各コードの中身

1. datetimeのnowメソッドで現在の時刻を求める。

datetimeのnowメソッドimport datetime as dt now = dt.datetime.now() now #出力 # datetime.datetime(2020, 3, 27, 19, 16, 41, 332644)datetimeについてはこちら

2. datetimeのstrftimeメソッドで日付の書式を指定する。

datetimeのstrftimeメソッドtime = now.strftime('%Y%m%d-%H%M%S') time #出力 #'20200327-191641'・strftimeメソッドの詳しい説明はこちら

・指定子(%Yや%dなど)の種類についてはこちら

3. format関数でファイル名に変数が使えるようにする。

format関数time = now.strftime('%Y%m%d-%H%M%S') 'output_{}.csv'.format(time) #出力 # 'output_20200327-193206.csv'format関数の詳細はこちら

4. to_csvメソッドでcsvファイルとして出力

csvファイル出力df.to_csv('~/desktop/output_{}.csv'.format(time), index = False, encoding = 'utf_8_sig')to_csvメソッドについてはこちら

- 投稿日:2020-03-27T19:46:10+09:00

Pythonで毎日AtCoder #18

はじめに

前回

今日も類題です。数理の翼二日目#18

考えたこと

ABC095-A

カウントしてから*100するだけs = str(input()) print(700+s.count('o')*100)ABC085-A

sの4番目からが出力と共通の部分なのでスライスで保持。それに2019を連結しています。s = str(input()) print('2018'+s[4:])ABC069-B

len(s)から最初と最後の2文字を引いて解くだけs = str(input()) print(s[0]+str(len(s)-2)+s[-1])ABC082-B

1WA。文字列のsortとかが苦手

文字列のsortを忘れていたので、ordで数字に変換してsortしていました。辞書順の差を最大化するためにはsはa→z順、tはz→aにする。あとは比較するだけ。s = str(input()) t = str(input()) s = list(map(ord,s)) t = list(map(ord,t)) s.sort() t.sort(reverse=True) if s < t: print('Yes') else: print('No')まとめ

数理の翼で感化されたので、量子コンピュータの方もがんばる。では、また

- 投稿日:2020-03-27T19:11:34+09:00

【python】表データに名前を付けてcsvで出力する方法(to_csvメソッド)

【python】表データに名前を付けてcsvで出力する方法(to_csvメソッド)

pandasモジュールで読み込んだ表データや、加工・作成した表データを、csvファイルとしてローカルに出力する方法。

基本構文(基本オプション)

to_csv('ファイルパス', encording='utf_8_sig', index=False)

└ ①「'ファイルパス'」:絶対パスでも相対パスでも可

└ ②「encording='utf_8_sig'」:文字コードの指定

└ ③「index=False」:pandasで表を読み込んだり作成した際に自動で生成されるインデックス番号の列を含めない指示。①は必須。②、③は省略可。

▼補足「utf_8_sig」について

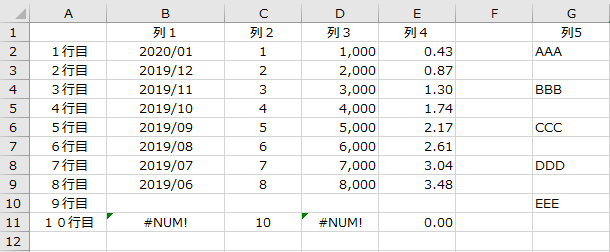

utf_8の上位互換みたいなもの。BOM付き、BOMなし両方のutf8を正常に読み込める。■実例

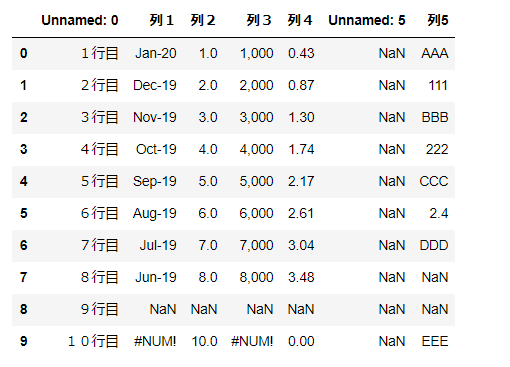

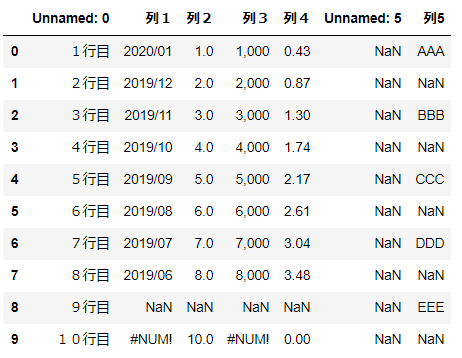

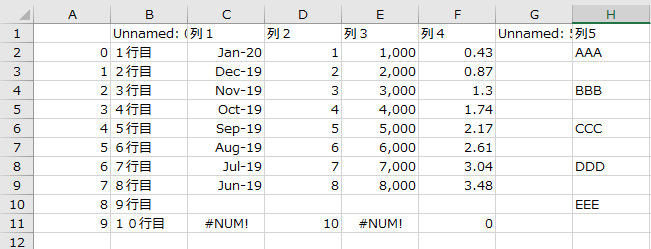

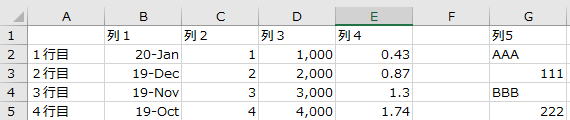

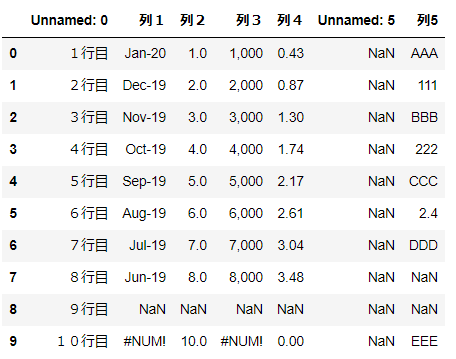

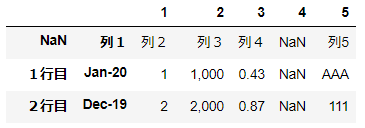

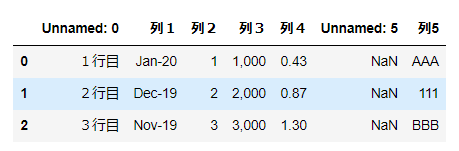

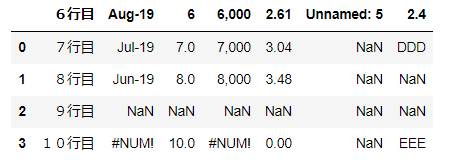

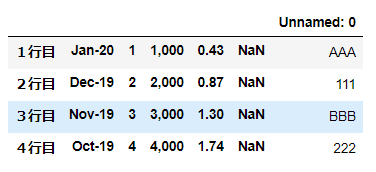

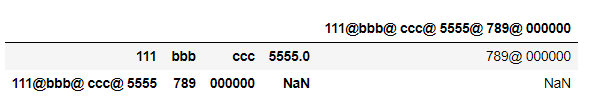

▼例:下記表を出力する場合

変数

dfに下記の表な表が入っている。pythonでcsvファイルを読み込む方法はこちら

▼csvファイルとして出力

実例df.to_csv("~/desktop/output.csv",index = False,encoding = "utf_8_sig")▼詳細

①「df.to_csv」

└データdf(変数)をcsvファイルに変換する。

②「"~/desktop/output.csv"」

└ 絶対パスで出力先を指定。

└ デスクトップにファイル名「outpu.csv」で出力。

└ 同じファイルがある場合は上書き。③「index = False」

└ 1列目のインデクス番号は不要④「encoding = "utf_8_sig"」

└ 文字コードはutf8のシグネチャー付き。※シート名はファイル名と同じになる。

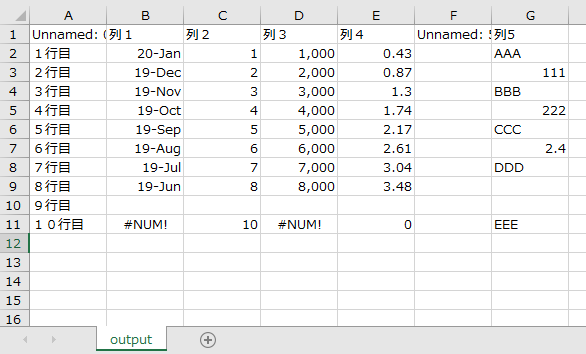

■出力結果

■文字化けとエラー

▼文字コードの指定がないと文字化け。

df.to_csv("~/desktop/output.csv",index = False)▼出力するファイル名が開かれた状態だとエラー

エラーdf.to_csv("~/desktop/output.csv",index = False) #出力 # PermissionError: [Errno 13] Permission denied: 'C:\\Users\desktop/output.csv'「Permission denied:」強力に拒否されたように見えるが、上書きできなかっただけ。

- 投稿日:2020-03-27T19:09:50+09:00

Pythonのargparseでファイルオブジェクトを引数とするオプションでのファイル上書き確認

動機

pythonの標準ライブラリにふくまれるコマンドライン・パーサーargparseでは、引数の型としてファイルオブジェクトを指定することができる。(argparse.FileType) 文字列からわざわざファイルオブジェクトを生成したりする必要がないので大変便利である。しかし、書き込みモード(

mode='w')を指定した場合でも有無を言わさず自動的に開いてしまうので、おっちょこちょいな人にとっては、意図せずにファイルを上書きして内容を消してしまう恐れがあり、大変危険である。そこで、ファイルの上書き確認を実装したので、やり方をわすれないようにメモしておく。実装例。

文末に挙げたサイトのやり方を参考にして拙作pdf_merge_multipagesに実装した例。

pdf_merge_multipages.py(抜粋)class FileTypeWithCheck(argparse.FileType): def __call__(self, string): if string and "w" in self._mode: if os.path.exists(string): sys.stderr.write(('File: "%s" exists. Is it OK to overwrite? [y/n] : ') % (string)) ans = sys.stdin.readline().rstrip() ypttrn = re.compile(r'^y(es)?$', re.I) m = ypttrn.match(ans) if not m: sys.stderr.write("Stop file overwriting.\n") sys.exit(1) # raise ValueError('Stop file overwriting') if os.path.dirname(string): os.makedirs(os.path.dirname(string), exist_ok=True) return super(FileTypeWithCheck, self).__call__(string) def __repr__(self): return super(FileTypeWithCheck, self).__repr__() .... .... def main(): argpsr = argparse.ArgumentParser(description='Merge multiple mages in PDF files w/o gap.') argpsr.add_argument('inputs', metavar='input-file', type=argparse.FileType('rb'), nargs='+', help='Input PDF file(s)') argpsr.add_argument('-output', metavar='filename', type=FileTypeWithCheck('wb'), nargs=1, help='Output file', dest='output', default='a.out.pdf') ... ... def main(): argpsr = argparse.ArgumentParser(description='Merge multiple mages in PDF files w/o gap.') argpsr.add_argument('inputs', metavar='input-file', type=argparse.FileType('rb'), nargs='+', help='Input PDF file(s)') argpsr.add_argument('-output', metavar='filename', type=FileTypeWithCheck('wb'), nargs=1, help='Output file', dest='output', default='a.out.pdf') ... ... if __name__ == '__main__': main()ファイルが存在していて上書きを回避したときに、そこでスクリプトを終了(

exit())するかもしくは例外を送出するかは、場合によって選択が必要であろう。上記の例ではexit()しているが、先にinputsの引数で読み込みモードでファイルが開かれていた場合に、それを閉じる処理をせずにスクリプトが終了することになる可能性が残るところがちょっと引っかかる点ではある。参考資料

- 投稿日:2020-03-27T19:08:40+09:00

PDFファイルの複数ページをマージンなく1ページにまとめるスクリプト

動機

PDFの複数ページを1ページにまとめる方法(2up, 4up, ... n-up)としては、たとえばmacOSの"プレビュー"などで、

「ファイル」→「プリント...」→「レイアウト」タブでページ数/枚を選択→「PDFとして保存」

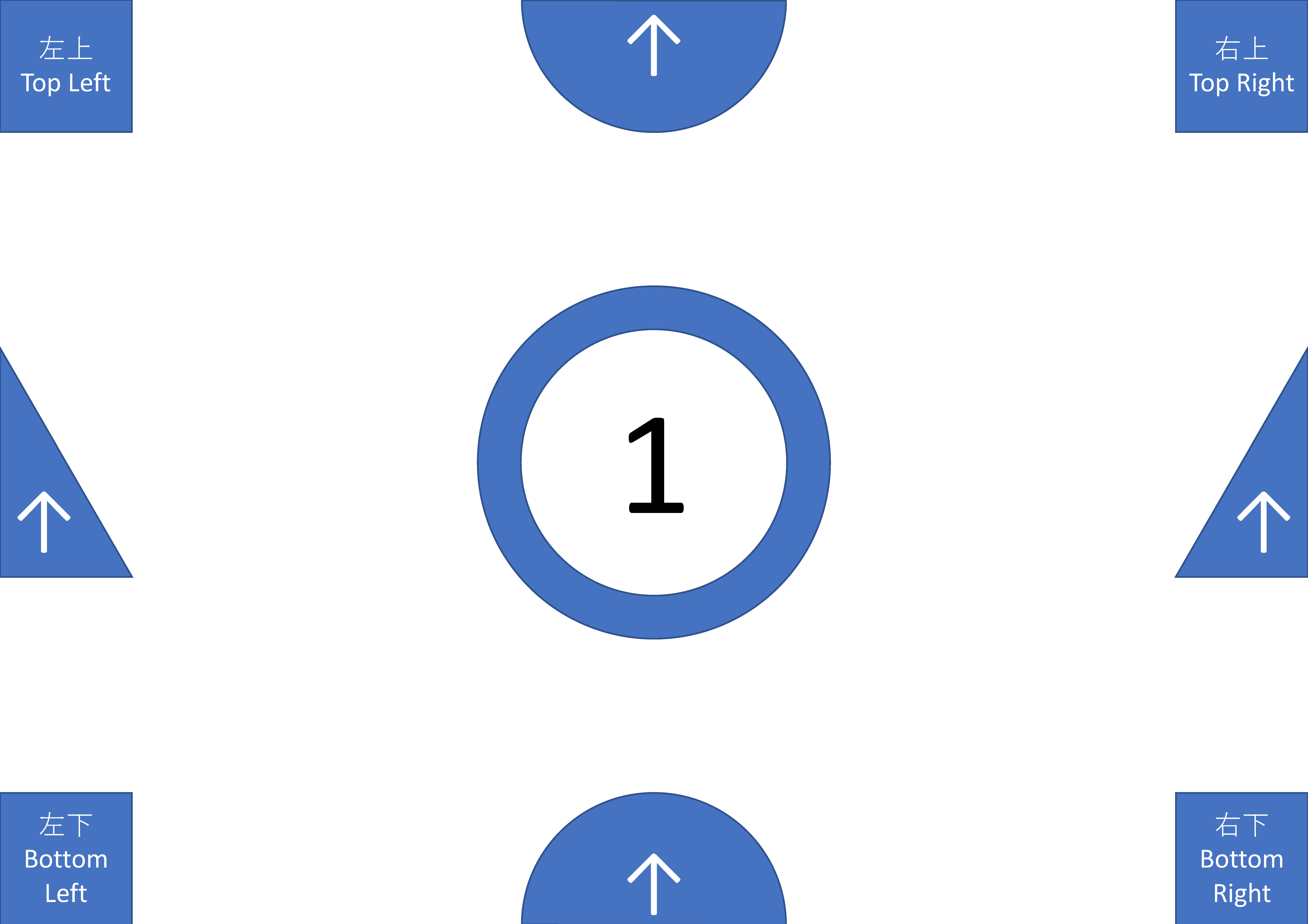

という方法が挙げられる。ところが、この方法だとまとめられたページとページの間にマージンが入ってしまうのを回避する方法が見当たらなかった。1ページ目と2ページ目がそれぞれ、

のようにページ端まで要素を含んだPDFファイルを上記の方法で2upしてみると、

のようにマージンが設定され、ページとページの間に隙間が空いてしまうことがわかる。lこれでは、たとえば大きな用紙を分割してスキャンしたPDFファイルをまとめて1ページに戻したいといった目的の場合の出力としてはちょっと残念な仕上がりである。いったんPostscript形式に変換して古くからあるpsnupを使う、という方法もあるとは思うが、マルチバイト文字とかフォントとか形式変換にともなう面倒なこともありうると思うので、PDFを取り扱うライブラリが存在しそうな最近のスクリプト言語で変換スクリプトを書くことにした。仕様

ちょっとだけ調べてみたところ、

PythonだとPyPDF2というライブラリが存在しているようなので、Pythonで実装してみることにする。仕様としては、macOSのプリントメニューのレイアウトタブで変更可能な点の主なものは、コマンドラインオプションとして選べるようにすることにした。

- 1ページにまとめるページ数を選べるようにする。

- ページを並べていく方向を何通りか選べるようにする。

- ページサイズに関しては、シンプルに元のページサイズを維持する。(例えばA4サイズのファイルを2upするとA3サイズのPDFファイルが出力される。)

- ページの回転については+-90度,180度の回転が選べるようにする。また、縦置きページと横置きページが混じっている場合に、それを揃える動作も選べるようにする。

- サイズが違うページが混在している場合に、サイズを揃えたり、ページ位置の揃え方も選べるようにした。

- PDFファイルのメタ情報を入力ファイルから引き継ぐことも可能なようにする。

実装

ファイルの置き場は下記。

実行例

2行3列でページをまとめる場合の例。

% ./pdf_merge_multipages.py -o merge_test.pdf -c 3 -l 2 test_samples/input_landsc ape_1.pdf test_samples/input_portleit_1.pdf詳しい使い方など

動作要件

- Python: 2.7で動作確認

- PyPDF2: https://pythonhosted.org/PyPDF2/

- version 1.26.0 で動作確認

使い方

usage: pdf_merge_multipages.py [-h] [-output filename] [-columns n_h] [-lines n_v] [-page-order opt] [-rotation opt] [-valign opt] [-align opt] [-metainfo opt] [-title text] input-file [input-file ...] Merge multiple mages in PDF files w/o gap. positional arguments: input-file Input PDF file(s) optional arguments: -h, --help show this help message and exit -output filename Output file -columns n_h # of columns of merged pages (default = 2) -lines n_v # of lines of merged pages (default = 1) -page-order opt Page order (choices=left2right[default], left2bottom, right2left, right2bottom) -rotation opt Page orientation (choices=none[default], flip, right, left, auto, rauto) -valign opt Page fitting (choices=resize, none[default], top, bottom, center, fit) -align opt Page fitting (choices=resize, none[default], right, left, center, fit) -metainfo opt Meta data for marged file (choices=full[default], none, partial, short) -title text set title in meta data for marged file (Default: output file name)オプション引数

-output filename: 出力ファイルの名前。指定しない場合のデフォルトは、a.out.pdf-columns nh,-lines n_v: レイアウトの指定: 入力PDFファイルのpageを、横n_h列×縦n_v行に配置する。指定しない場合のデフォルトは、2x1 ("2up")-page-order option: ページをレイアウトする配置する順番の指定。

left2right: 入力ファイルの最初のページを左上に配置。入力ファイルの続くページを右に順次配置していき、右端に到達したら、直下の段の左端または次ページの左上から右へ順次配置していく。(デフォルト)left2bottom: 入力ファイルの最初のページを左上に配置。入力ファイルの続くページを下に順次配置していき、下端に到達したら、右隣の列の上端または次ページの左上から下へ配置していく。left2top: 入力ファイルの最初のページを左下に配置。入力ファイルの続くページを上に順次配置していき、上端に到達したら、右隣の列の下端または次ページの左下から上へ配置していく。right2left: 入力ファイルの最初のページを右上に配置。入力ファイルの続くページを左に順次配置していき、左端に到達したら、直下の段の右端または次ページの右上から左へ順次配置していく。right2bottom:入力ファイルの最初のページを右上に配置。入力ファイルの続くページを下に順次配置していき、下端に到達したら、左隣の列の上端または次ページの右上から下へ配置していく。right2top: 入力ファイルの最初のページを右下に配置。入力ファイルの続くページを上に順次配置していき、上端に到達したら、左隣の列の下端または次ページの右下から上へ配置していく。-rotation option: ページの回転

none: 配置される入力ファイルの各ページを回転しない。(デフォルト)flip: 配置される入力ファイルの各ページを上下反転する。right: 配置される入力ファイルの各ページを右に90度回転する。left: 配置される入力ファイルの各ページを左に90度回転する。auto: 出力ページの先頭に配置される入力ファイルの各ページが縦置き(横置き)の場合、出力ファイルの同じページに配置される他の入力ファイルの各ページが横置き(縦置き)の場合には左に90度回転して配置し、そうでない場合には回転せずに配置する。rauto: 出力ページの先頭に配置される入力ファイルのページが縦置き(横置き)の場合、出力ファイルの同じページに配置される他の入力ファイルの各ページが横置き(縦置き)の場合には右に90度回転して配置し、そうでない場合には回転せずに配置する。

-valign opttion: 配置されるページの縦方向位置調整の指定

none,bottom: 下揃え (デフォルト)center: 上下中央揃えtop: 上揃えresize: 出力ページの先頭に配置される入力ファイルのページの縦方向のサイズに合わせて縮小する。-algin resizeまたは-algin fitと同時に指定された場合には、より縮小率の小さくなる可能性があるが、その場合でもレイアウト間隔は、出力ページの先頭に配置される入力ファイルのページの縦方向のサイズとなる。fit: 出力ページの先頭に配置される入力ファイルのページの縦方向のサイズに合わせて縮小する。-algin resizeまたは-algin fitと同時に指定された場合には、より縮小率の小さくなり、レイアウト間隔も出力ページの先頭に配置される入力ファイルのページの縦方向のサイズより小さくなることがある。

-align opttion: 配置されるページの横方向位置調整の指定

none,left: 右揃え (デフォルト)center: 左右中央揃えright: 右揃えresize: 出力ページの先頭に配置される入力ファイルのページの横方向のサイズに合わせて縮小する。-valgin resizeまたは-valgin fitと同時に指定された場合には、より縮小率の小さくなる可能性があるが、その場合でもレイアウト間隔は、出力ページの先頭に配置される入力ファイルのページの横方向のサイズとなる。fit: 出力ページの先頭に配置される入力ファイルのページの横方向のサイズに合わせて縮小する。-valgin resizeまたは-valgin fitと同時に指定された場合には、より縮小率の小さくなり、レイアウト間隔も出力ページの先頭に配置される入力ファイルのページの横方向のサイズより小さくなることがある。

-metainfo options: 出力ファイルのメタ情報の指定

full: 入力ファイルのメタ情報を結合したものに追記して生成。(デフォルト)partial: 入力ファイルのメタ情報を結合したものの一部に追記して生成short: '/Title'、'/Creater', '/Producer'のみ生成none: 出力ファイルのメタ情報を生成しない.(PyPDF2のデフォルト値が指定される。)

-title text: 入力ファイルのメタ情報のタイトルを指定する。(デフォルトは出力ファイル名)

- 投稿日:2020-03-27T19:07:44+09:00

PySideツールのテスト駆動開発スタートアップ

はじめに

PySideとPytestでテスト駆動開発をするためのメモ。

開発環境

Windows 10

Python 3.7.7

Pytestサンプルファイル -> GitHub

初期整備

ディレクトリとファイルの準備

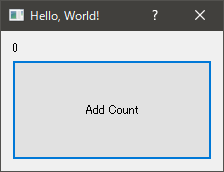

ディレクトリroot |- sample | |- __init__.py | |- gui.py |- tests | |- __init__.py | |- conftest.py | |- unit | |- test_gui.py |- requirments.txtここでのツールのソースとなるgui.pyは以下のようなものを用意した。

sample/gui.pyimport sys from PySide2 import QtCore from PySide2 import QtWidgets class SampleDialog(QtWidgets.QDialog): def __init__(self, *args): super(SampleDialog, self).__init__(*args) self.number = 0 self.setWindowTitle('Hello, World!') self.resize(300, 200) layout = QtWidgets.QVBoxLayout() self.label = QtWidgets.QLabel(str(self.number)) layout.addWidget(self.label) self.button = QtWidgets.QPushButton('Add Count') self.button.clicked.connect(self.add_count) self.button.setMinimumSize(200, 100) layout.addWidget(self.button) self.setLayout(layout) self.resize(200, 100) def add_count(self): self.number += 2 self.label.setText(str(self.number)) def main(): app = QtWidgets.QApplication.instance() if app is None: app = QtWidgets.QApplication(sys.argv) gui = SampleDialog() gui.show() app.exec_() if __name__ == '__main__': main()requirements.txt に必要モジュールを書く

PySide2 Pytestvenv環境を作成する

- rootディレクトリに行く

python -m venv .venv- venv環境を有効にする:

.venv\Script\Activate.batpip install -r requirements.txtconftest.pyでモジュールへのパスをつなぐ

tests/conftest.pyimport os import sys sys.path.append(os.path.dirname(os.path.abspath(__file__)))Pytest公式では、setup.pyを用いた、

pip install -e .を使って、インストールする事が推奨されているが、TAの(DCCツールも含めた)ツールリリース環境の場合、必ずしもpip環境を提供するわけにはいかない場合がある。そういった場合に、余計なディレクトリ構成を取りたくない事があるので、conftest.pyを使用して、Pytestの実行じにrootにパスを通しておく。

もちろん、

pip installを前提とした配布環境の場合はpip intall -e .を出来るように、 setup.pyをroot下に配置し、pip install出来るようにしておくと良い。また、同様に、Mayaなどの外部ツールなどで必要なモジュールがあるみたいな時には、ここでパスを通しに行くと良い。

テストコードの実装

Pytestでのテストファイル

Pytestは、test_.py や *test.pyというファイルを検索して、自動で取得しにいく。

さらに、そのファイルの中のtestという関数を探して実行する。

さらに、その関数をまとめたい場合には、Test*(Ex: TestGui)といったクラスを作ると、これもまたPytestが自動で拾いに行ってくれる。テストを書いていく

tests/unit/test_gui.pyimport sys from PySide2 import QtCore from PySide2 import QtWidgets from PySide2 import QtTest def test_add_count(): from sample import gui app = QtWidgets.QApplication.instance() if app is None: app = QtWidgets.QApplication(sys.argv) gui = gui.SampleDialog() gui.show() QtTest.QTest.mouseClick(gui.button, QtCore.Qt.LeftButton) n1 = gui.number QtTest.QTest.mouseClick(gui.button, QtCore.Qt.LeftButton) n2 = gui.number assert abs(n2 - n1) == 1QtTestを使う

ここで出てくるのが、QtTestで、PySideはこうしてテスト用のモジュールを提供してくれている。

ユーザーは、「『ボタンをクリックすることによって』、ラベルの数字が1上がる」という事を認識するので、この動作が正しくなるように、『ボタンをクリックすることによって』というのをテスト上でシミュレートする必要がある。

ここでQtTestは、QtTest.QTest.mousClick()を使う事によって、その動作をシミュレートすることができるようになる。つまり、上記のtest_add_countでは、次のことをQtTestで行っている

- 最初のQtTest.QTest.mousClicke()で、「guiのボタンを左マウスクリックする」

- その時のnumberクラス変数の値をn1として格納する

- 次のQtTest.QTest.mousClicke()で、「guiのボタンを左マウスクリックする」

- 二回目のクリックした状態でのnumberクラス変数の値をn2として格納する

- assertでその二つの格納した値を比較し、差が1であることを確認する

これにより、 ボタンをクリックした際の変更が、正しくカウントの上昇が1づつであるということを保証することができる。

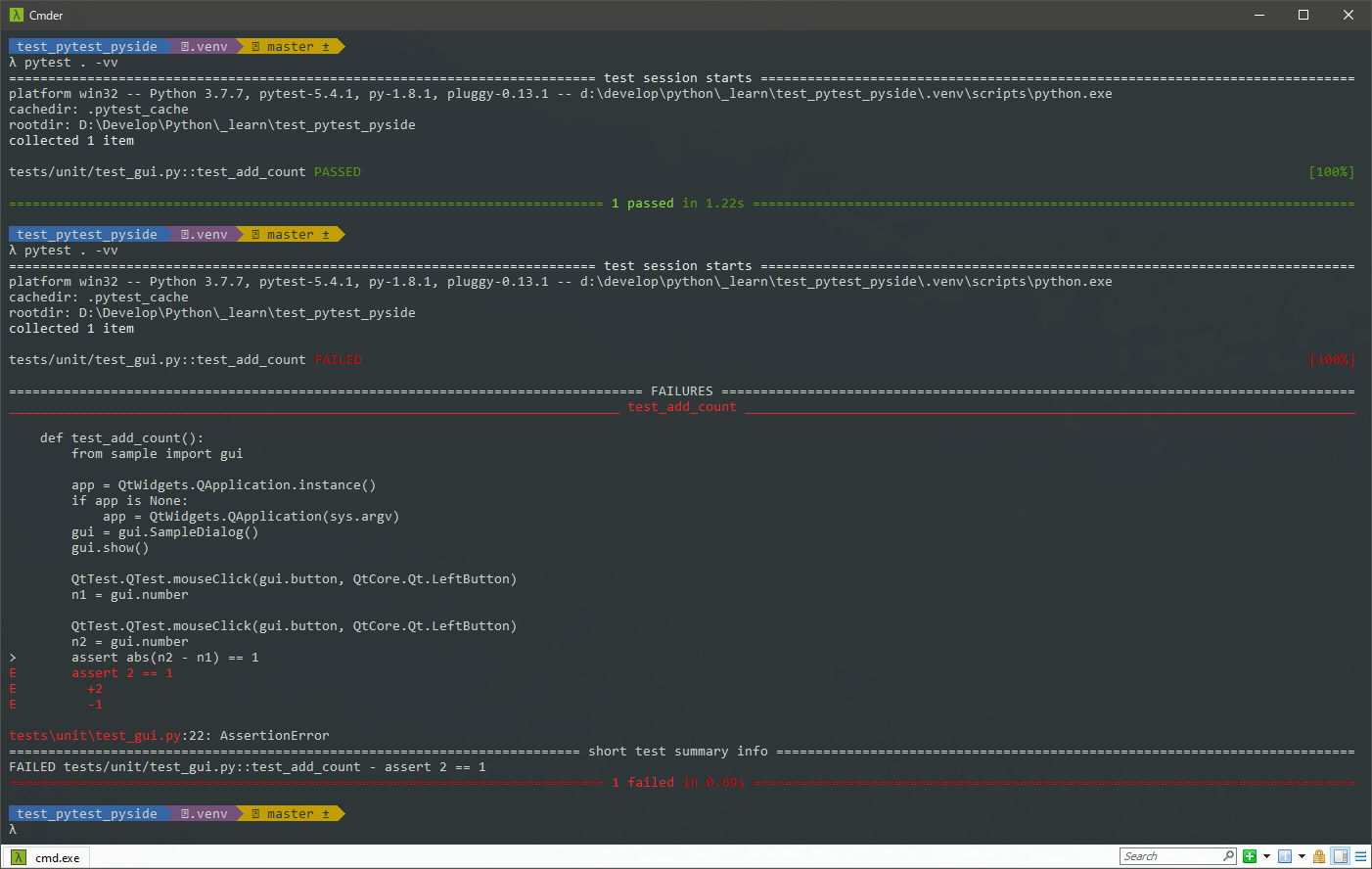

テストコマンドを実行する

テストを実行する際のコマンドをルートディレクトリでとりあえずこれを実行すればいい。

pytest .すると、次の様な結果が得られる。

================================== test session starts ================================== platform win32 -- Python 3.7.7, pytest-5.4.1, py-1.8.1, pluggy-0.13.1 rootdir: D:\Develop\Python\_learn\test_pytest_pyside collected 1 item F [100%] ======================================= FAILURES ======================================== ____________________________________ test_add_count _____________________________________ def test_add_count(): from sample import gui app = QtWidgets.QApplication.instance() if app is None: app = QtWidgets.QApplication(sys.argv) gui = gui.SampleDialog() gui.show() QtTest.QTest.mouseClick(gui.button, QtCore.Qt.LeftButton) n1 = gui.number QtTest.QTest.mouseClick(gui.button, QtCore.Qt.LeftButton) n2 = gui.number > assert abs(n2 - n1) == 1 E assert 2 == 1 E + where 2 = abs((4 - 2)) tests\unit\test_gui.py:22: AssertionError ================================ short test summary info ================================ FAILED tests/unit/test_gui.py::test_add_count - assert 2 == 1 =================================== 1 failed in 0.89s ===================================これを説明すると、

テスト上のコードを見ての通り、add_countは、最初の実行と次の実行時の値の差が1であってほしいという開発者の意図がある。しかしながら、ソースコードを見てみると、self.number += 2としてあり、『ボタンをクリックすることによって』実行された処理の結果の差が2の結果を出してしまっている。では、この

self.number += 1に変え、「1づつ増える(つまり常に増える差は1)」にしてみると、pytest .を実行した際に、次の結果が得られる。================================== test session starts ================================== platform win32 -- Python 3.7.7, pytest-5.4.1, py-1.8.1, pluggy-0.13.1 rootdir: D:\Develop\Python\_learn\test_pytest_pyside collected 1 item . [100%] =================================== 1 passed in 1.44s ===================================この様にして、テストの成功の結果が得られた。

まとめ

Pytestは先のように、自動でテストコードを拾ってきたり、conftest.pyを使用することによって、あらかじめ前提としたい環境設定も用意することができるので、様々な排他的環境を少ないコードで、自動で構築できるようになる。

PySideは、QtTestという機能をあらかじめ用意しており、これを使用することでGuiの挙動をシミュレートできることがわかる。よくよく調べていくと、Pytestにももっともっと機能が豊富にあり、QtTestも同じく機能をたくさん持っているので、このスタートアップを経て、様々なテスト実装を行えて良ければと考える。

- 投稿日:2020-03-27T19:07:44+09:00

PySide & Pytest での テスト駆動開発 スタートアップ

はじめに

PySide勉強会での、「PySide & Pytest で テスト駆動開発スタートアップ」の補足記事。

および、PySideとPytestでテスト駆動開発をするためのメモ。開発環境

Windows 10

Python 3.7.7

Pytestサンプルファイル

初期整備

ディレクトリとファイルの準備

ディレクトリroot |- sample | |- __init__.py | |- gui.py |- tests | |- __init__.py | |- conftest.py | |- unit | |- test_gui.py |- requirments.txtここでのツールのソースとなるgui.pyは以下のようなものを用意した。

sample/gui.pyimport sys from PySide2 import QtCore from PySide2 import QtWidgets class SampleDialog(QtWidgets.QDialog): def __init__(self, *args): super(SampleDialog, self).__init__(*args) self.number = 0 self.setWindowTitle('Hello, World!') self.resize(300, 200) layout = QtWidgets.QVBoxLayout() self.label = QtWidgets.QLabel(str(self.number)) layout.addWidget(self.label) self.button = QtWidgets.QPushButton('Add Count') self.button.clicked.connect(self.add_count) self.button.setMinimumSize(200, 100) layout.addWidget(self.button) self.setLayout(layout) self.resize(200, 100) def add_count(self): self.number += 2 self.label.setText(str(self.number)) def main(): app = QtWidgets.QApplication.instance() if app is None: app = QtWidgets.QApplication(sys.argv) gui = SampleDialog() gui.show() app.exec_() if __name__ == '__main__': main()requirements.txt に必要モジュールを書く

PySide2 Pytestvenv環境を作成する

- rootディレクトリに行く

python -m venv .venv- venv環境を有効にする:

.venv\Script\Activate.batpip install -r requirements.txtconftest.pyでモジュールへのパスをつなぐ

tests/conftest.pyimport os import sys sys.path.append(os.path.dirname(os.path.abspath(__file__)))Pytest公式では、setup.pyを用いた、

pip install -e .を使って、インストールする事が推奨されているが、TAの(DCCツールも含めた)ツールリリース環境の場合、必ずしもpip環境を提供するわけにはいかない場合がある。そういった場合に、余計なディレクトリ構成を取りたくない事があるので、conftest.pyを使用して、Pytestの実行じにrootにパスを通しておく。

もちろん、

pip installを前提とした配布環境の場合はpip intall -e .を出来るように、 setup.pyをroot下に配置し、pip install出来るようにしておくと良い。また、同様に、Mayaなどの外部ツールなどで必要なモジュールがあるみたいな時には、ここでパスを通しに行くと良い。

テストコードの実装

Pytestでのテストファイル

Pytestは、test_.py や *test.pyというファイルを検索して、自動で取得しにいく。

さらに、そのファイルの中のtestという関数を探して実行する。

さらに、その関数をまとめたい場合には、Test*(Ex: TestGui)といったクラスを作ると、これもまたPytestが自動で拾いに行ってくれる。テストを書いていく

tests/unit/test_gui.pyimport sys from PySide2 import QtCore from PySide2 import QtWidgets from PySide2 import QtTest def test_add_count(): from sample import gui app = QtWidgets.QApplication.instance() if app is None: app = QtWidgets.QApplication(sys.argv) gui = gui.SampleDialog() gui.show() QtTest.QTest.mouseClick(gui.button, QtCore.Qt.LeftButton) n1 = gui.number QtTest.QTest.mouseClick(gui.button, QtCore.Qt.LeftButton) n2 = gui.number assert abs(n2 - n1) == 1QtTestを使う

ここで出てくるのが、QtTestで、PySideはこうしてテスト用のモジュールを提供してくれている。

ユーザーは、「『ボタンをクリックすることによって』、ラベルの数字が1上がる」という事を認識するので、この動作が正しくなるように、『ボタンをクリックすることによって』というのをテスト上でシミュレートする必要がある。

ここでQtTestは、QtTest.QTest.mousClick()を使う事によって、その動作をシミュレートすることができるようになる。つまり、上記のtest_add_countでは、次のことをQtTestで行っている

- 最初のQtTest.QTest.mousClicke()で、「guiのボタンを左マウスクリックする」

- その時のnumberクラス変数の値をn1として格納する

- 次のQtTest.QTest.mousClicke()で、「guiのボタンを左マウスクリックする」

- 二回目のクリックした状態でのnumberクラス変数の値をn2として格納する

- assertでその二つの格納した値を比較し、差が1であることを確認する

これにより、 ボタンをクリックした際の変更が、正しくカウントの上昇が1づつであるということを保証することができる。

テストコマンドを実行する

テストを実行する際のコマンドをルートディレクトリでとりあえずこれを実行すればいい。

pytest .すると、次の様な結果が得られる。

======================================= test session starts ======================================== platform win32 -- Python 3.7.7, pytest-5.4.1, py-1.8.1, pluggy-0.13.1 rootdir: D:\Develop\Python\_learn\test_pytest_pyside collected 1 item tests\unit\test_gui.py F [100%] ============================================= FAILURES ============================================= __________________________________________ test_add_count __________________________________________ def test_add_count(): from sample import gui app = QtWidgets.QApplication.instance() if app is None: app = QtWidgets.QApplication(sys.argv) gui = gui.SampleDialog() gui.show() QtTest.QTest.mouseClick(gui.button, QtCore.Qt.LeftButton) n1 = gui.number QtTest.QTest.mouseClick(gui.button, QtCore.Qt.LeftButton) n2 = gui.number > assert abs(n2 - n1) == 1 E assert 2 == 1 E + where 2 = abs((4 - 2)) tests\unit\test_gui.py:22: AssertionError ===================================== short test summary info ====================================== FAILED tests/unit/test_gui.py::test_add_count - assert 2 == 1 ======================================== 1 failed in 0.67s =========================================これを説明すると、

テスト上のコードを見ての通り、add_countは、最初の実行と次の実行時の値の差が1であってほしいという開発者の意図がある。しかしながら、ソースコードを見てみると、self.number += 2としてあり、『ボタンをクリックすることによって』実行された処理の結果の差が2の結果を出してしまっている。では、この

self.number += 1に変え、「1づつ増える(つまり常に増える差は1)」にしてみると、pytest .を実行した際に、次の結果が得られる。======================================= test session starts ======================================== platform win32 -- Python 3.7.7, pytest-5.4.1, py-1.8.1, pluggy-0.13.1 rootdir: D:\Develop\Python\_learn\test_pytest_pyside collected 1 item tests\unit\test_gui.py . [100%] ======================================== 1 passed in 0.70s =========================================この様にして、テストの成功の結果が得られた。

まとめ

Pytestは先のように、自動でテストコードを拾ってきたり、conftest.pyを使用することによって、あらかじめ前提としたい環境設定も用意することができるので、様々な排他的環境を少ないコードで、自動で構築できるようになる。

PySideは、QtTestという機能をあらかじめ用意しており、これを使用することでGuiの挙動をシミュレートできることがわかる。よくよく調べていくと、Pytestにももっともっと機能が豊富にあり、QtTestも同じく機能をたくさん持っているので、このスタートアップを経て、様々なテスト実装を行えて良ければと考える。

- 投稿日:2020-03-27T19:02:10+09:00

AtCoder Beginner Contest 084 過去問復習

所要時間

感想

FXが今日は惨敗していて萎えてます。相場は巻き返さないし週末は東京封鎖だし最悪ですね。

今回は難しくないのですが、エラトステネスの篩をバグらせました。生きるのがしんどい。A問題

引き算、特に感想なし。

answerA.pyprint(48-int(input()))B問題

一文字ずつチェックします。

0~9の文字列を作ってその中にあるかで計算しましたが、"0"以上"9"以下としてもOKなようです。answerB.pynum=list("0123456789") a,b=map(int,input().split()) s=input() for i in range(a+b+1): if i!=a: if s[i] not in num: print("No") break else: if s[i]!="-": print("No") break else: print("Yes")C問題

頭が弱すぎて何回もミスりました。

それぞれの駅に何時に着くかをnowという変数に記録しておきます。そして、それぞれの駅についてはs以降かつその駅についた時間以降で最も小さいfの倍数を考えてそこからcだけ進めば次の駅に進むというのをまずは文字に起こして冷静に式を立てることで解けます。

僕はこれがFXの考えすぎでできませんでした。なんて頭が悪いんでしょうか。answerC.pyimport math n=int(input()) csf=[list(map(int,input().split())) for i in range(n-1)] for j in range(n-1): now=0 for i in range(j,n-1): if csf[i][1]>=now: now=csf[i][1]+csf[i][0] else: now=csf[i][1]-((csf[i][1]-now)//csf[i][2])*csf[i][2]+csf[i][0] print(now) print(0)D問題

区間のクエリが与えられてるので累積和の差を考えれば良いのは明らかです。

つまり、クエリの計算を行う前に"2017に似た数"を先に求めておけば良く、エラトステネスの篩(他記事で紹介しています。)を用いて素数列挙してから"2017に似た数"をチェックし、累積和を考えておけば良いです。

しかし、エラトステネスの篩がバグっていた上に"2017に似た数"をチェックするつもりが、ただ素数をチェックしたために時間がかかってしまいました。こういうケアレスミスを無くすようにしたいです。answerD.cc#include<algorithm>//sort,二分探索,など #include<bitset>//固定長bit集合 #include<cmath>//pow,logなど #include<complex>//複素数 #include<deque>//両端アクセスのキュー #include<functional>//sortのgreater #include<iomanip>//setprecision(浮動小数点の出力の誤差) #include<iostream>//入出力 #include<map>//map(辞書) #include<numeric>//iota(整数列の生成),gcdとlcm(c++17) #include<queue>//キュー #include<set>//集合 #include<stack>//スタック #include<string>//文字列 #include<unordered_map>//イテレータあるけど順序保持しないmap #include<unordered_set>//イテレータあるけど順序保持しないset #include<utility>//pair #include<vector>//可変長配列 using namespace std; typedef long long ll; //マクロ #define REP(i,n) for(ll i=0;i<(ll)(n);i++) #define REPD(i,n) for(ll i=(ll)(n)-1;i>=0;i--) #define FOR(i,a,b) for(ll i=(a);i<=(b);i++) #define FORD(i,a,b) for(ll i=(a);i>=(b);i--) #define ALL(x) (x).begin(),(x).end() //sortなどの引数を省略したい #define SIZE(x) ((ll)(x).size()) //sizeをsize_tからllに直しておく #define MAX(x) *max_element(ALL(x)) #define INF 1000000000000 #define MOD 10000007 #define MA 100000 #define PB push_back #define MP make_pair #define F first #define S second ll sieve_check[MA+1];//i番目が整数iに対応(1~100000) //エラトステネスの篩を実装する void es(){ FOR(i,2,MA)sieve_check[i]=1; //1のところが素数、ここでは0が素数でない for(ll i=2;i<=1000;i++){ if(sieve_check[i]==1){ for(ll j=2;j<=ll(MA/i);j++){ sieve_check[j*i]=0; } } } } signed main(){ es(); vector<ll> pre(MA+1);FOR(i,1,MA)pre[i]=(i%2==1&&sieve_check[i]&&sieve_check[(i+1)/2]); REP(i,MA)pre[i+1]+=pre[i]; ll q;cin >> q; vector< pair<ll,ll> > ans(q);REP(i,q) cin >> ans[i].F >> ans[i].S; REP(i,q)cout << pre[ans[i].S]-pre[ans[i].F-1] << endl; }

- 投稿日:2020-03-27T18:34:03+09:00

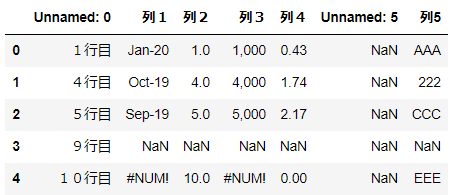

【python】pandasのread_html読み込みエラーの対処法

【python】pandasのread_html読み込みエラーの対処法

pandasの「read_html」というメソッドでhtmlファイルも読み込めるのか!と思い、試したところ連続で別々のエラーが、、

▼4つの課題(エラー)

①「ImportError: lxml not found, please install it」②「ImportError: html5lib not found, please install it」

③「ImportError: BeautifulSoup4 (bs4) not found, please install it」

④「ValueError: No tables found」

▼対応ポイント

・使うためにはライブラリをいくつかインストールしておく必要がある。・データ取得は表(テーブル)に対してのみ。

■対処法実例

下記3つのライブラリをインストールしてから、

表を含むページを指定して実行すればできます。①ライブラリのインストール

ライブラリのインストールpip install lxml pip install html5lib pip install bs4②データ取得実行

データ取得実行import pandas as pd url = 'https://stocks.finance.yahoo.co.jp/stocks/detail/?code=998407.O' df = pd.read_html(url)URL:日経平均株価【998407】:国内指数 - Yahoo!ファイナンス

無事取得できました。

補足

▼なぜ3つもインストールする必要があるのか

ページの解析はBeautifulSoup4で行う。その際、テーブルの解析にlxmlを使用。

lxmlでhtmlの解析に失敗した場合に、html5libを使用する。html5libは解析能力に優れ、htmlの補完もできるが重い。

ただし、html5libもインストールすることが推奨されている。

▼read_htmlでできること

要素のみにしか使えない。

子要素の、、 、 、。

■エラー詳細

第1のエラー

エラーimport pandas as pd url = 'https://www.yahoo.co.jp/' df = pd.read_html(url) #出力 # ImportError: lxml not found, please install itlxmlがインストールされていないとのこと。

lxmlとは?

pythonのライブラリの一種で、htmlやxmlを解析するもの。

非常に軽い。ただし、厳密なマークアップにしか対応していないため、解析に失敗することがある。

lxmlのインストール

pip install lxml第2のエラー

html5libとは?

lxmlを無事インストールし、再度実行したところ別のエラーが、、

「ImportError: html5lib not found, please install it」

こちらはhtml5を解析するもの。

lxmlよりも高性能。無効なマークアップから正しいマークアップを自動生成できる。その代わり重い。

lxmlでhtmlの解析に失敗した場合に、使われる。

html5libのインストール

pip install html5lib

第3のエラー

BeautifulSoup4 (bs4) とは?

html5libを無事インストールし、再度コードを実行したところ、新たなエラーが、、

「ImportError: BeautifulSoup4 (bs4) not found, please install it」

BeautifulSoup4 (bs4) はhtmlやxmlを解析するもの。

ページ解析の大本となるライブラリ。

今回のテーブルの解析には、バックエンドでlxmlやhtml5libが使われる。BeautifulSoup4 (bs4) のインストール

pip install bs4第4のエラー

bs4を無事インストールし、再度コードを実行したところ、新たなエラーが、、

「ValueError: No tables found」

どうやら表データしかとってこれないらしい。。

表データの取得

表データがあるサイトとして、yahooファイナンスの日経平均株価【998407】ページでトライ。

https://m.finance.yahoo.co.jp/stock?code=998407.O

read_htmlimport pandas as pd url = 'https://stocks.finance.yahoo.co.jp/stocks/detail/?code=998407.O' df = pd.read_html(url) df

出力結果を見る

[ 0 1 2 3 0 日経平均株価 NaN 19389.43 前日比+724.83(+3.88%), 0 1 0 株価予想 どうなる?明日の日経平均, 0 1 0 日経平均株価 NYダウ 1 TOPIX ナスダック総合 2 ジャスダックインデックス S&P 500 3 香港ハンセン FTSE 100 4 上海総合 DAX 5 ムンバイSENSEX30 CAC 40, 0 \ 0 ピクテ・ゴールド(H有)その他リターン(1年)19.94% 1 グローバルSDGs株式ファンドその他リターン(1年)5.27% 2 eMAXIS Slim全世界株式(オール・カントリー)その他リターン(1年)3.91% 1 0 パインブリッジ・キャピタル証券F(H有)その他リターン(1年)6.35% 1 リスクコントロール世界資産分散ファンドその他リターン(1年)4.81% 2 米国株式配当貴族(年4回決算型)国際株式リターン(1年)2.21% , 0 \ 0 総合 値上がり率 1. 新都HLD+45.45% 2. スガイ化+28.30% 3. アマガ... 1 0 東証1部 値上がり率 1. カネコ種+19.95% 2. セグエG+18.28% 3. 小林... ]

- 投稿日:2020-03-27T17:44:55+09:00

Python未経験者が言語処理100本ノックをやってみる14~16

真面目に仕事をしていると投稿をサボることになり、

真面目に投稿していると仕事をサボることになる。これは難しい問題だ・・・(真剣)

(休みの日はやらん)これの続きでーす。

Python未経験者が言語処理100本ノックをやってみる10~13

https://qiita.com/earlgrey914/items/afdb6458a2c9f1c00c2e

14. 先頭からN行を出力

自然数Nをコマンドライン引数などの手段で受け取り,入力のうち先頭のN行だけを表示せよ.確認にはheadコマンドを用いよ.

コマンドライン引数を得るには以下のように書けばいいらしい。

arg.pyimport sys args = sys.argv<参考URL>

https://qiita.com/orange_u/items/3f0fb6044fd5ee2c3a37args[1]とインデックスが1から始まっているのは,実行結果を見れば理由が分かる

実行結果からわかるように,リストとして値が返されるふむふむ。コマンドライン引数はリストとして返され、1からカウントと。

えーと、問題文が少し難解だけど、「2」がコマンドライン引数で渡されたら

merge.txtの2行を出力すればいいってことかしらね。これでどうでしょ。

otto.pyimport os.path import sys os.chdir((os.path.dirname(os.path.abspath(__file__)))) args = sys.argv linedata = [] with open('merge.txt', mode="r") as f: linedata = f.read().splitlines() print(linedata[args[1])])[ec2-user@ip-172-31-34-215 02]$ python3 enshu14.py 2 Traceback (most recent call last): File "enshu14.py", line 11, in <module> print(linedata[args[1]]) TypeError: list indices must be integers or slices, not strおっと、コマンドライン引数

argsのリストは文字列で返されるようだ。入力値は文字列型として扱われる

では文字列→整数変換を。

int(args[1])ですねenshu14.pyimport os.path import sys os.chdir((os.path.dirname(os.path.abspath(__file__)))) args = sys.argv linedata = [] with open('merge.txt', mode="r") as f: linedata = f.read().splitlines() for i in range(int(args[1])): print(linedata[i])引数を2とか5にしてみて検証。

[ec2-user@ip-172-31-34-215 02]$ python3 enshu14.py 2 高知県 江川崎 埼玉県 熊谷 [ec2-user@ip-172-31-34-215 02]$ python3 enshu14.py 5 高知県 江川崎 埼玉県 熊谷 岐阜県 多治見 山形県 山形 山梨県 甲府 [ec2-user@ip-172-31-34-215 02]$うーん簡単。

headとも比較。[ec2-user@ip-172-31-34-215 02]$ head -n 2 merge.txt 高知県 江川崎 埼玉県 熊谷 [ec2-user@ip-172-31-34-215 02]$ head -n 5 merge.txt 高知県 江川崎 埼玉県 熊谷 岐阜県 多治見 山形県 山形 山梨県 甲府 [ec2-user@ip-172-31-34-215 02]$~5日ほどサボり~

末尾のN行を出力

自然数Nをコマンドライン引数などの手段で受け取り,入力のうち末尾のN行だけを表示せよ.確認にはtailコマンドを用いよ.

リストを末尾から参照するには

[-1]、[-2]、[-3]、・・・と参照していけば良いらしい。<参考URL>

https://qiita.com/komeiy/items/971ead35d33c25923222これ出力結果はどうなればいいんだ?

["a", "b", "c", "d"]のリストがあって、引数が2ならc, dと出力されればいいのか?d, cなのか?

tailで確認せよとのことなので、まずtailだとどう出力されるか確認してみよう。[ec2-user@ip-172-31-34-215 02]$ tail -n 2 merge.txt 山形県 鶴岡 愛知県 名古屋 [ec2-user@ip-172-31-34-215 02]$ tail -n 5 merge.txt 埼玉県 鳩山 大阪府 豊中 山梨県 大月 山形県 鶴岡 愛知県 名古屋なるほど。

c, dの順で出せば良いんだな。enshu15.pyimport os.path import sys os.chdir((os.path.dirname(os.path.abspath(__file__)))) args = sys.argv linedata = [] with open('merge.txt', mode="r") as f: linedata = f.read().splitlines() linedata_reverse =[] for i in range(int(args[1])): linedata_reverse.append(linedata[-i-1]) for i in (reversed(linedata_reverse)): print(i)うい。できました。

リストの反転はreversed()ですね。[ec2-user@ip-172-31-34-215 02]$ python3 enshu15.py 2 山形県 鶴岡 愛知県 名古屋 [ec2-user@ip-172-31-34-215 02]$ python3 enshu15.py 5 埼玉県 鳩山 大阪府 豊中 山梨県 大月 山形県 鶴岡 愛知県 名古屋結果もOK。

Pythonってこういうリストの反転とかスライスとか、便利な標準機能が多いなーって感じます。

16. ファイルをN分割する

自然数Nをコマンドライン引数などの手段で受け取り,入力のファイルを行単位でN分割せよ.同様の処理をsplitコマンドで実現せよ.

まずは

splitコマンドがどのようなものか試してみる。

お気づきかと思うが、筆者はPythonも初心者だし、UNIXコマンドも初心者である。[ec2-user@ip-172-31-34-215 02]$ split -l 2 -d merge.txt test [ec2-user@ip-172-31-34-215 02]$ ll total 112 -rw-rw-r-- 1 ec2-user ec2-user 435 Mar 19 17:12 merge.txt -rw-rw-r-- 1 ec2-user ec2-user 37 Mar 25 15:48 test00 -rw-rw-r-- 1 ec2-user ec2-user 37 Mar 25 15:48 test01 -rw-rw-r-- 1 ec2-user ec2-user 43 Mar 25 15:48 test02 -rw-rw-r-- 1 ec2-user ec2-user 34 Mar 25 15:48 test03 -rw-rw-r-- 1 ec2-user ec2-user 34 Mar 25 15:48 test04 -rw-rw-r-- 1 ec2-user ec2-user 37 Mar 25 15:48 test05 -rw-rw-r-- 1 ec2-user ec2-user 37 Mar 25 15:48 test06 -rw-rw-r-- 1 ec2-user ec2-user 37 Mar 25 15:48 test07 -rw-rw-r-- 1 ec2-user ec2-user 34 Mar 25 15:48 test08 -rw-rw-r-- 1 ec2-user ec2-user 34 Mar 25 15:48 test09 -rw-rw-r-- 1 ec2-user ec2-user 34 Mar 25 15:48 test10 -rw-rw-r-- 1 ec2-user ec2-user 37 Mar 25 15:48 test11 [ec2-user@ip-172-31-34-215 02]$ cat test00 高知県 江川崎 埼玉県 熊谷なるほど。

ではまず、「行単位でN分割」の部分を作ろう。enshu16.pyimport os.path import sys os.chdir((os.path.dirname(os.path.abspath(__file__)))) args = sys.argv a = int(args[1]) linedata = [] with open('merge.txt', mode="r") as f: linedata = f.read().splitlines() for i in range(0, len(linedata), a): print(linedata[i:i+a:])とりあえずこれで、リストを分割したかのように表示することができた。

[ec2-user@ip-172-31-34-215 02]$ python3 enshu16.py 1 ['高知県\t江川崎'] ['埼玉県\t熊谷'] ['岐阜県\t多治見'] ['山形県\t山形'] ['山梨県\t甲府'] ['和歌山県\tかつらぎ'] ['静岡県\t天竜'] ['山梨県\t勝沼'] ['埼玉県\t越谷'] ['群馬県\t館林'] ['群馬県\t上里見'] ['愛知県\t愛西'] ['千葉県\t牛久'] ['静岡県\t佐久間'] ['愛媛県\t宇和島'] ['山形県\t酒田'] ['岐阜県\t美濃'] ['群馬県\t前橋'] ['千葉県\t茂原'] ['埼玉県\t鳩山'] ['大阪府\t豊中'] ['山梨県\t大月'] ['山形県\t鶴岡'] ['愛知県\t名古屋'] [ec2-user@ip-172-31-34-215 02]$ python3 enshu16.py 2 ['高知県\t江川崎', '埼玉県\t熊谷'] ['岐阜県\t多治見', '山形県\t山形'] ['山梨県\t甲府', '和歌山県\tかつらぎ'] ['静岡県\t天竜', '山梨県\t勝沼'] ['埼玉県\t越谷', '群馬県\t館林'] ['群馬県\t上里見', '愛知県\t愛西'] ['千葉県\t牛久', '静岡県\t佐久間'] ['愛媛県\t宇和島', '山形県\t酒田'] ['岐阜県\t美濃', '群馬県\t前橋'] ['千葉県\t茂原', '埼玉県\t鳩山'] ['大阪府\t豊中', '山梨県\t大月'] ['山形県\t鶴岡', '愛知県\t名古屋'] [ec2-user@ip-172-31-34-215 02]$ python3 enshu16.py 5 ['高知県\t江川崎', '埼玉県\t熊谷', '岐阜県\t多治見', '山形県\t山形', '山梨県\t甲府'] ['和歌山県\tかつらぎ', '静岡県\t天竜', '山梨県\t勝沼', '埼玉県\t越谷', '群馬県\t館林'] ['群馬県\t上里見', '愛知県\t愛西', '千葉県\t牛久', '静岡県\t佐久間', '愛媛県\t宇和島'] ['山形県\t酒田', '岐阜県\t美濃', '群馬県\t前橋', '千葉県\t茂原', '埼玉県\t鳩山'] ['大阪府\t豊中', '山梨県\t大月', '山形県\t鶴岡', '愛知県\t名古屋']次はファイルへの保存だ。

この問題では、元ファイルを 第2引数の名前+通番 の名前のファイルに分割する必要がある。

どうすればいいんだろう?~10分ほどググる~

<参考URL>

https://news.mynavi.jp/article/zeropython-40/なんかこういうふうに書けば連番ファイルの保存ができそう。

kou.pyfor i in range(5): print("テスト-{0:03d}.jpg".format(i + 1))テスト-001.jpg テスト-002.jpg テスト-003.jpg テスト-004.jpg テスト-005.jpg

format()というものを使うようだ。

個人的にものすごく難しく感じる。なんでダブルクオーテーションで囲った文字に直接.format()をつけて、値を渡せるんだ・・・?

{}の書き方のおかげだと思うんだけどこれなんて記法?~5分ほどググる~

うーん、なんだかシックリこないなー。

別にformat()を使わずとも他の書き方でもいけるようだし、他の書き方を使おう。

よくわからんものを「動くから」と使っていると後からさらによくわからんことになる。経験則です。<参考URL>

https://gammasoft.jp/blog/python-string-format/書き直し↓

tes.pyfor i in range(3): with open("テスト"+ str(i+1) +".txt", 'a') as f: print("てすと", file=f )[ec2-user@ip-172-31-34-215 02]$ ll total 124 -rw-rw-r-- 1 ec2-user ec2-user 3 Mar 27 17:15 テスト1.txt -rw-rw-r-- 1 ec2-user ec2-user 3 Mar 27 17:15 テスト2.txt -rw-rw-r-- 1 ec2-user ec2-user 3 Mar 27 17:15 テスト3.txtよし、これで良い。単に連結演算子を使えばいいだけだった。

ダサいかもしれないけど、俺にとっては一番わかりやすい。では課題の回答を作成。

enshu16.pyimport os.path import sys os.chdir((os.path.dirname(os.path.abspath(__file__)))) args = int(sys.argv[1]) linedata = [] with open('merge.txt', mode="r") as f: linedata = f.read().splitlines() for i in range(0, len(linedata), args): with open("テスト"+ str(i+1) +".txt", 'a') as f: output = linedata[i:i+args:] for j in output: print(j, file =f)[ec2-user@ip-172-31-34-215 02]$ python3 enshu16.py 2 [ec2-user@ip-172-31-34-215 02]$ ll total 160 -rw-rw-r-- 1 ec2-user ec2-user 37 Mar 27 17:30 テスト11.txt -rw-rw-r-- 1 ec2-user ec2-user 37 Mar 27 17:30 テスト13.txt -rw-rw-r-- 1 ec2-user ec2-user 37 Mar 27 17:30 テスト15.txt -rw-rw-r-- 1 ec2-user ec2-user 34 Mar 27 17:30 テスト17.txt -rw-rw-r-- 1 ec2-user ec2-user 34 Mar 27 17:30 テスト19.txt -rw-rw-r-- 1 ec2-user ec2-user 37 Mar 27 17:30 テスト1.txt -rw-rw-r-- 1 ec2-user ec2-user 34 Mar 27 17:30 テスト21.txt -rw-rw-r-- 1 ec2-user ec2-user 37 Mar 27 17:30 テスト23.txt -rw-rw-r-- 1 ec2-user ec2-user 37 Mar 27 17:30 テスト3.txt -rw-rw-r-- 1 ec2-user ec2-user 43 Mar 27 17:30 テスト5.txt -rw-rw-r-- 1 ec2-user ec2-user 34 Mar 27 17:30 テスト7.txt -rw-rw-r-- 1 ec2-user ec2-user 34 Mar 27 17:30 テスト9.txt -rw-rw-r-- 1 ec2-user ec2-user 530 Mar 27 17:29 enshu16.py -rw-rw-r-- 1 ec2-user ec2-user 435 Mar 19 17:12 merge.txt [ec2-user@ip-172-31-34-215 02]$ cat テスト1.txt 高知県 江川崎 埼玉県 熊谷できたぞー。

通番を0埋めしていないから並び順が無茶苦茶ね。

通番を0埋めするときは多分format()が役に立つんだろうな、と気づきました。

今回は使わないけどそのうち使います。ここまで多分3時間くらいかかりました!!!!!!!!

2章はわりと簡単ですね。あとqiita投稿に慣れてきて、逆にやる気がなくなってきたせいでダラダラやってます。

- 投稿日:2020-03-27T17:12:57+09:00

SQLite3を簡単に使ってみる

SQLiteは,小規模なデータベースをサクっと作りたいときに使われるデータベースマネジメントシステム(DBMS)のひとつです.

データベースとは

データを登録したり,削除したり,検索したりするシステムのこと.

参照:データベースのきほん

いまさら聞けないデータベースとは?データベースの種類

- MySQL

- PostgreSQL

- SQLite

- Oracle DB

などがあります.(参照:MySQL、PostgreSQL、SQLite、Oracle DBの比較)

中でも,SQLite3はPythonの標準ライブラリに既に入っていて,機能が少なく,手軽に使えます.

SQLite3の使い方

pythonとは別に,SQLを書く必要があります.

#インポート import sqlite3 #データベースに接続 filepath = "test2.sqlite" conn = sqlite3.connect(filepath) #filepathと同名のファイルがなければ,ファイルが作成されます #テーブルを作成 cur = conn.cursor() cur.execute("DROP TABLE IF EXISTS items") cur.execute("""CREATE TABLE items( item_id INTEGER PRIMARY KEY, name TEXT UNIQUE, price INTEGER )""") conn.commit() #単発でデータを挿入 cur.execute('INSERT INTO items (name , price) VALUES (?,?)',("Orange", 520)) conn.commit() #連続でデータを挿入 cur = conn.cursor() data = [("Mango",770),("Kiwi", 400), ("Grape",800),("Peach",940),("Persimmon",700), ("Banana",400)] cur.executemany( "INSERT INTO items (name, price) VALUES (?,?)", data) conn.commit()以上でデータベースの構築と,データの登録ができました.

conn.commit()を実行しないと,データベースにコマンドが反映されないことに注意.全データを表示してみます.

#全データを抽出する cur = conn.cursor() cur.execute("SELECT item_id, name, price FROM items") items_list = cur.fetchall() items_list[(1, 'Orange', 520), (2, 'Mango', 770), (3, 'Kiwi', 400), (4, 'Grape', 800), (5, 'Peach', 940), (6, 'Persimmon', 700), (7, 'Banana', 400)]for文で1つずつ表示してみます.