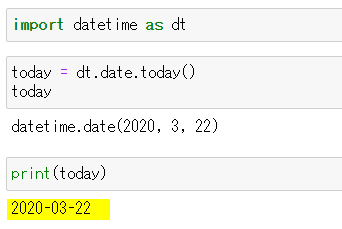

- 投稿日:2020-03-22T23:37:00+09:00

【minimize入門】SEIRモデルでデータ解析する♬

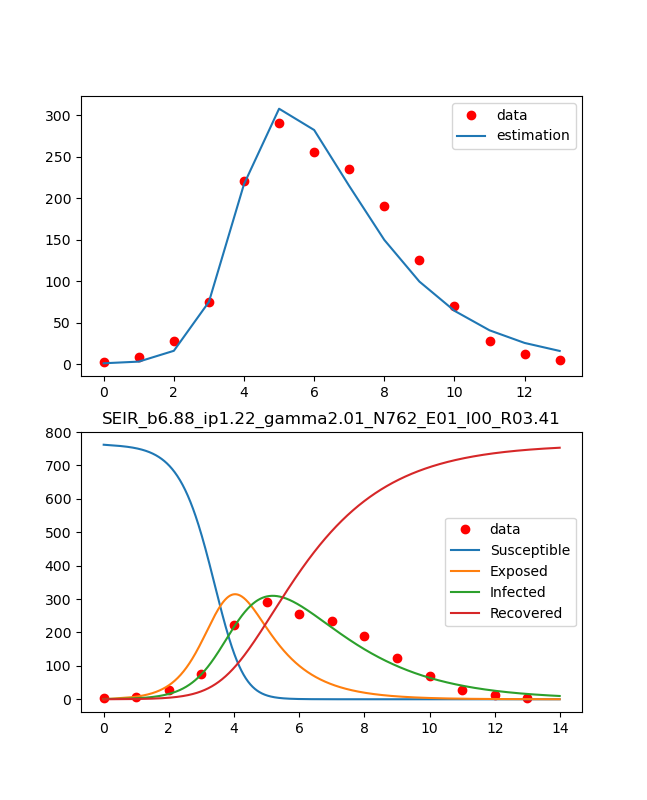

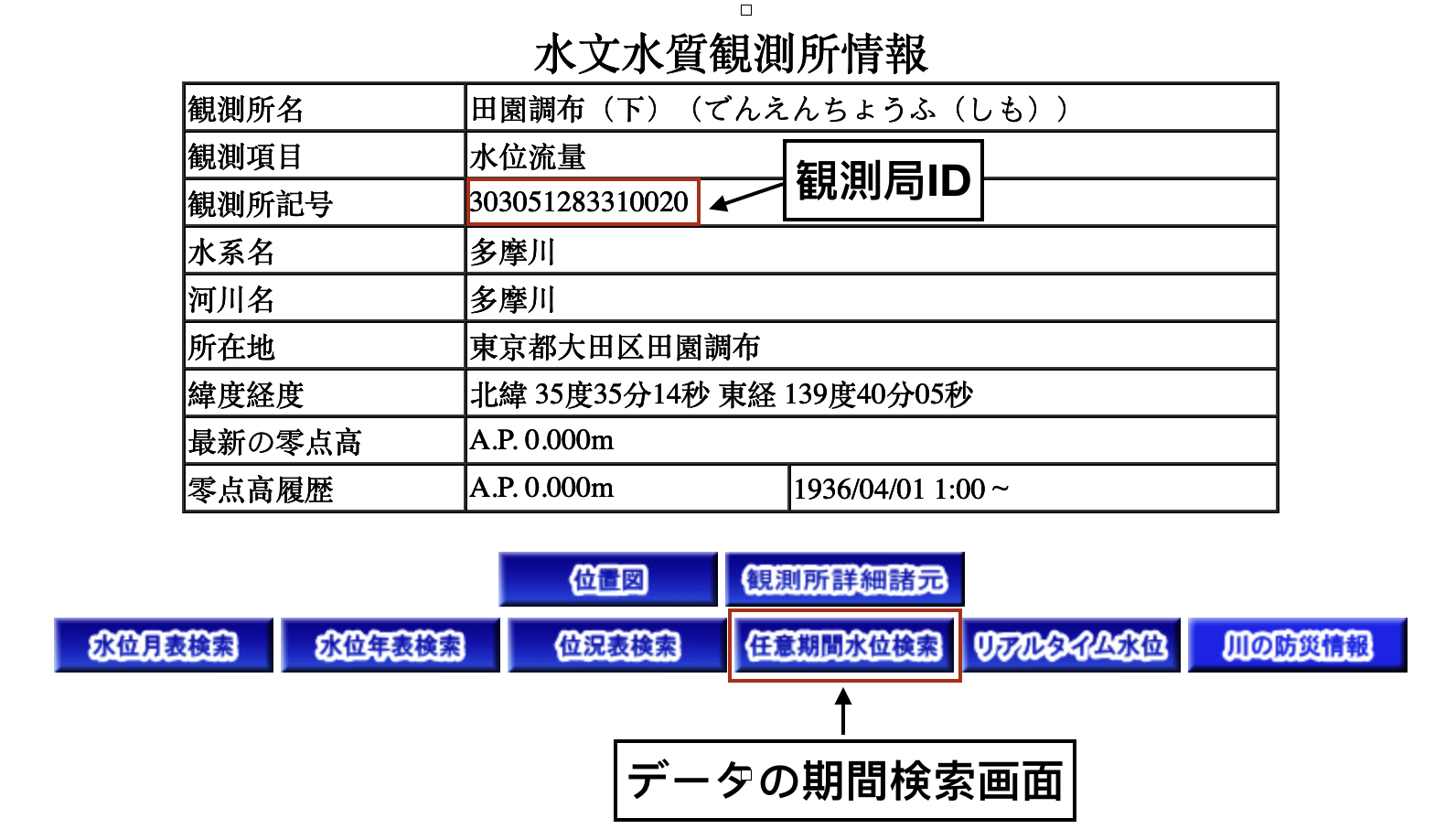

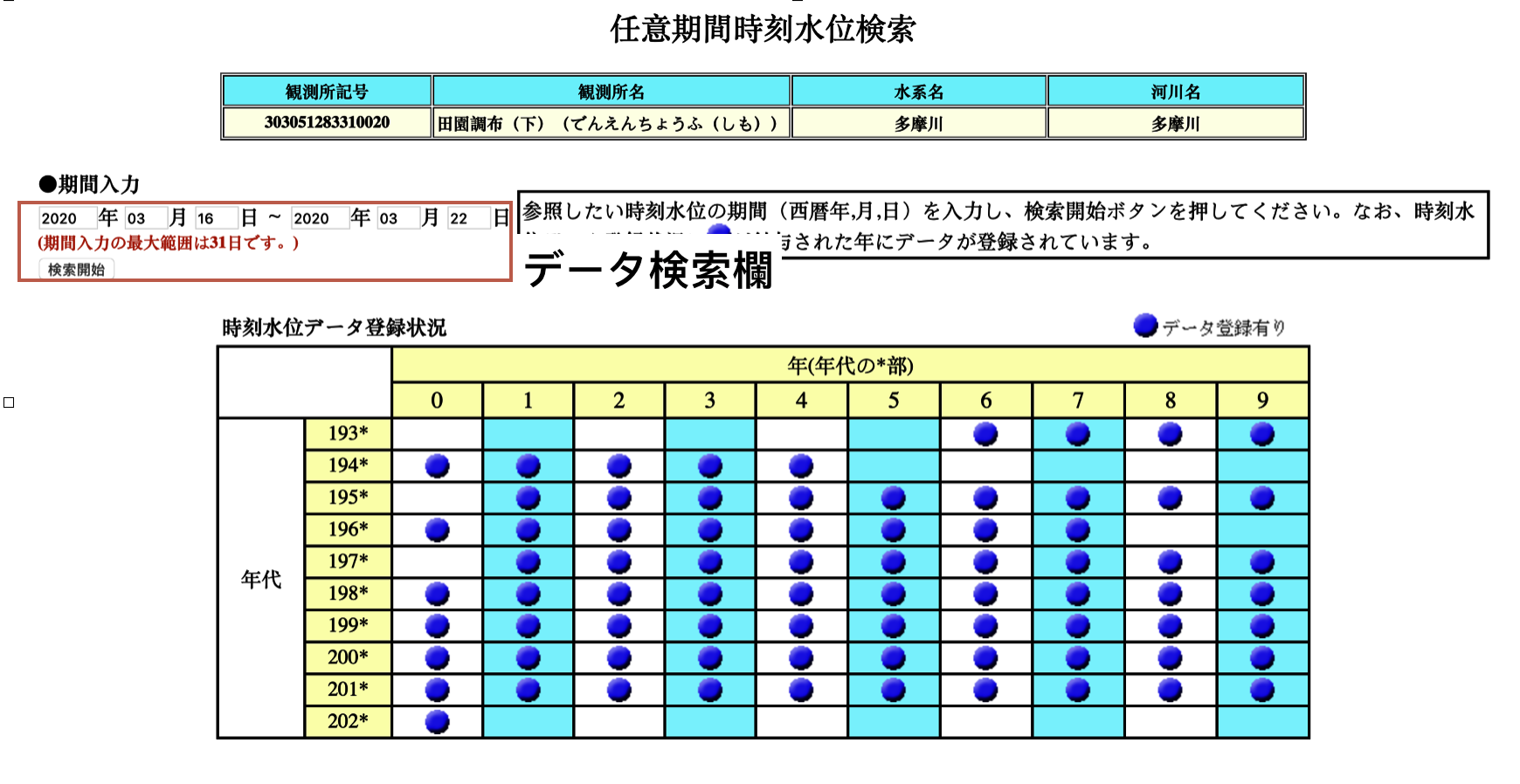

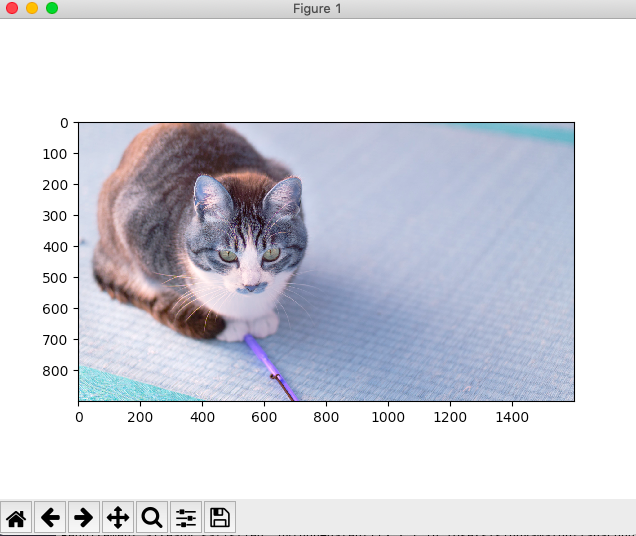

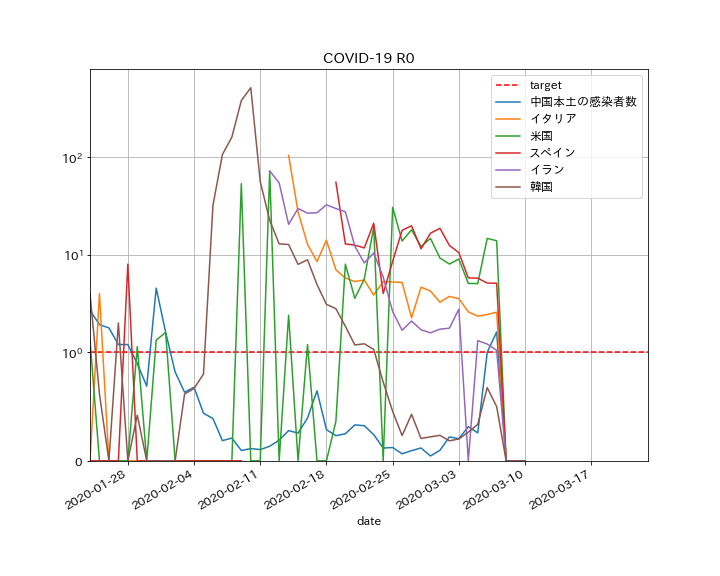

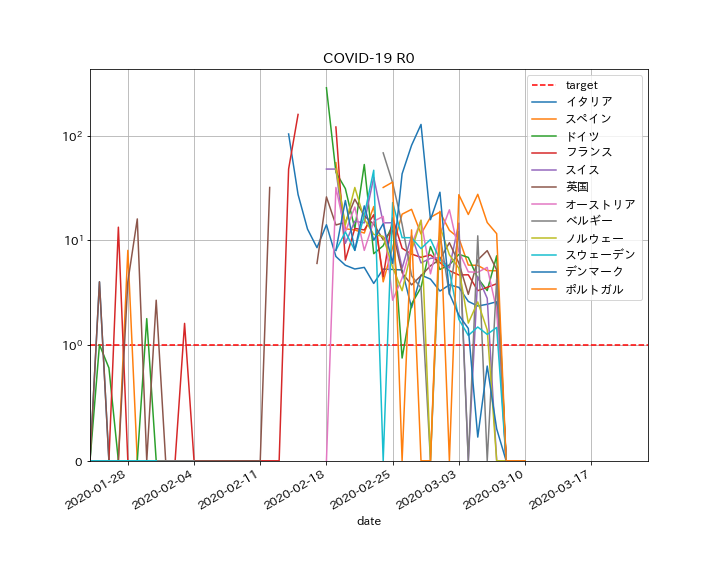

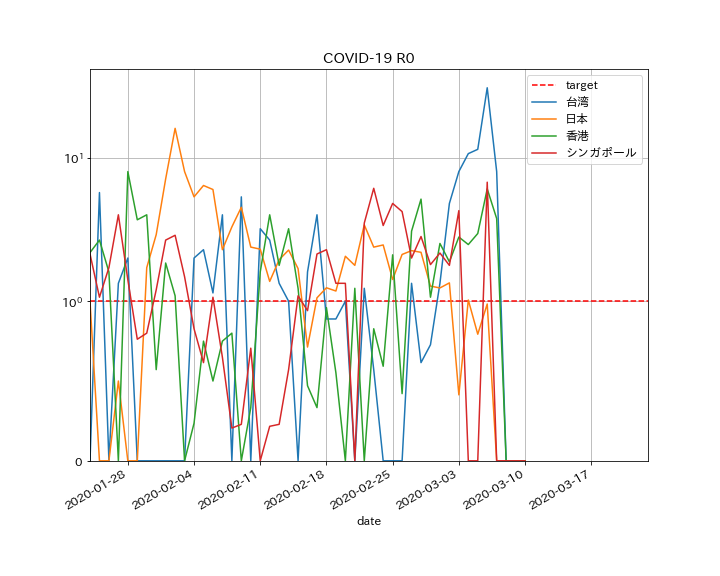

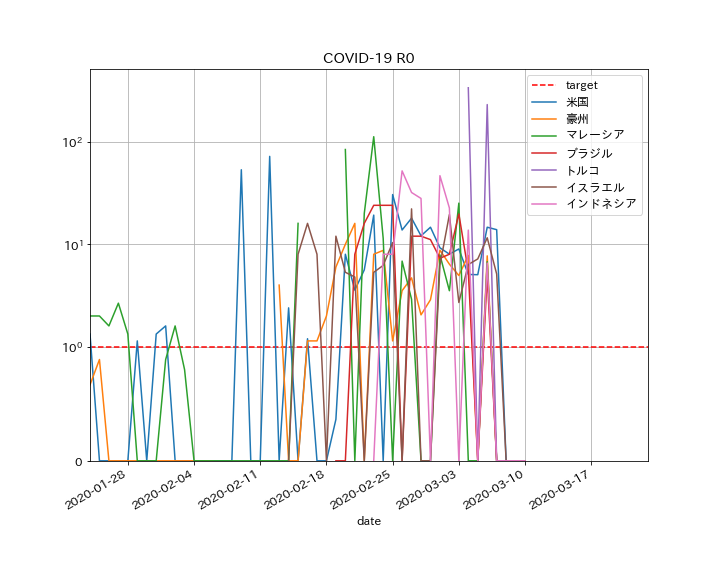

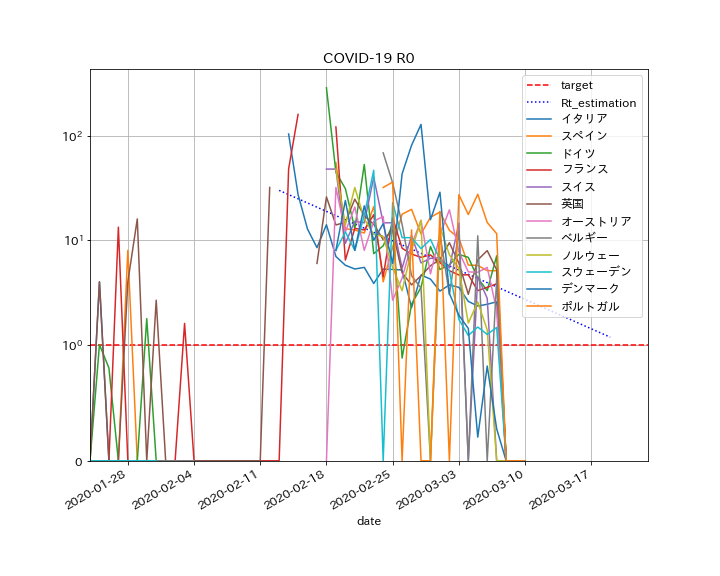

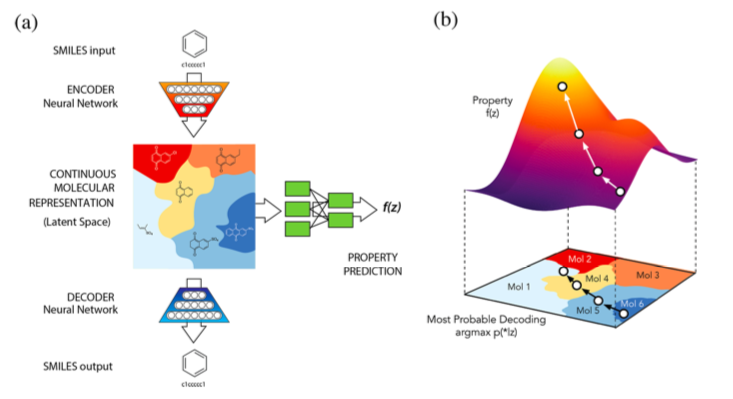

COVID-19のデータ解析する準備として、以下のグラフを出力するまでの解説をする。

この図は、与えられたdataに対して感染症のSEIRモデルにminimize@scipyを利用してフィッティングした図である。

手法は、ほぼ以下の参考のとおりです。どちらもいろいろな意味で参考になりました。

【参考】

①感染症数理モデル事始め PythonによるSEIRモデルの概要とパラメータ推定入門

②感染病の数学予測モデル (SIRモデル):事例紹介(1)

③SEIRモデルで新型コロナウイルスの挙動を予測してみた。やったこと

・コード解説

・SIRモデルとSEIRモデルでフィッティングしてみる

・その他のモデル・コード解説

コード全体は以下に置いた。

・collective_particles/minimize_params.py

解説は上記の参考に譲り、ここでは今回利用したコードの解説をする。なお、データは参考②から利用させていただいた。また、minimizeのコードは参考①を参考にさせていただいた。

利用するLibは以下のとおりである。

今回はWindows10のconda環境のkeras-gpu環境で実施しているが、scipyも含めて以前インストール済である。#include package import numpy as np from scipy.integrate import odeint from scipy.optimize import minimize import matplotlib.pyplot as plt以下にSEIRモデルの微分方程式を定義している。

ここでNをどうするかは適宜判断することになるが、今回の命題では参考②の掲出論文からN=763人であり、固定とした。

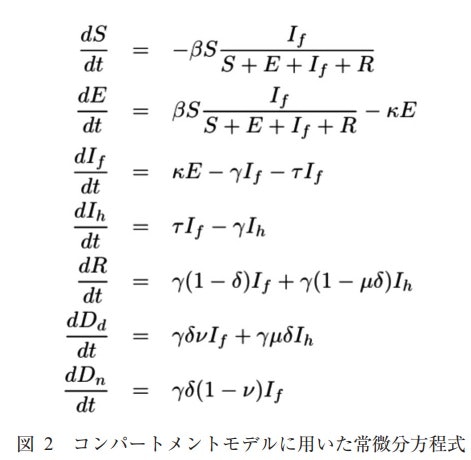

SEIRモデルの微分方程式は以下のとおり

ここで、参考①ではNを変数betaに押し込めてしまって、陽には表していないが、ウワン的には以下の式の方が分かりやすい。

以下は、参考③から引用させていただいた。{\begin{align} \frac{dS}{dt} &= -\beta \frac{SI}{N} \\ \frac{dE}{dt} &= \beta \frac{SI}{N} -\epsilon E \\ \frac{dI}{dt} &= \epsilon E -\gamma I \\ \frac{dR}{dt} &= \gamma I \\ \end{align} }上記を見ながら以下を見ると、まんまなので理解できると思う。

#define differencial equation of seir model def seir_eq(v,t,beta,lp,ip): N=763 a = -beta*v[0]*v[2]/N b = beta*v[0]*v[2]/N-(1/lp)*v[1] c = (1/lp)*v[1]-(1/ip)*v[2] d = (1/ip)*v[2] return [a,b,c,d]まず、通常の微分方程式として初期値に基づいて解を求めている。

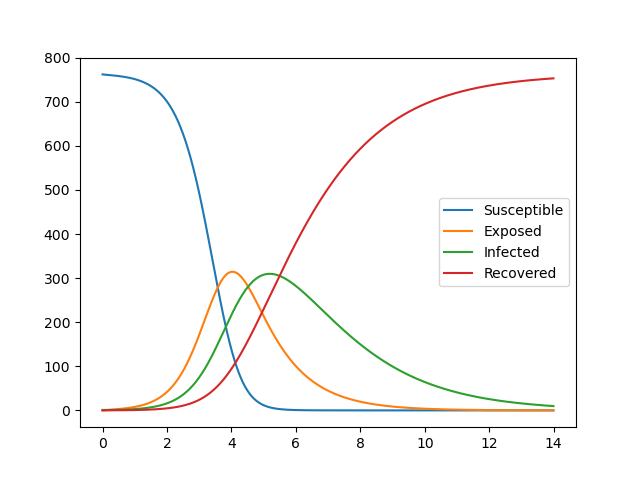

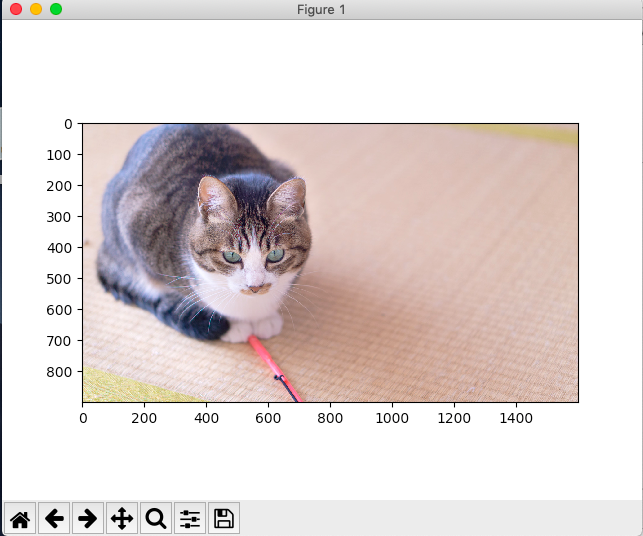

#solve seir model N,S0,E0,I0=762,0,1,0 ini_state=[N,S0,E0,I0] beta,lp,ip=6.87636378, 1.21965986, 2.01373496 #2.493913 , 0.95107715, 1.55007883 t_max=14 dt=0.01 t=np.arange(0,t_max,dt) plt.plot(t,odeint(seir_eq,ini_state,t,args=(beta,lp,ip))) #0.0001,1,3 plt.legend(['Susceptible','Exposed','Infected','Recovered']) plt.pause(1) plt.close()結果は以下のとおり、ここでパラメータを推定して変化させていけば大体のフィッティングはできるが複雑なものでは難しい。

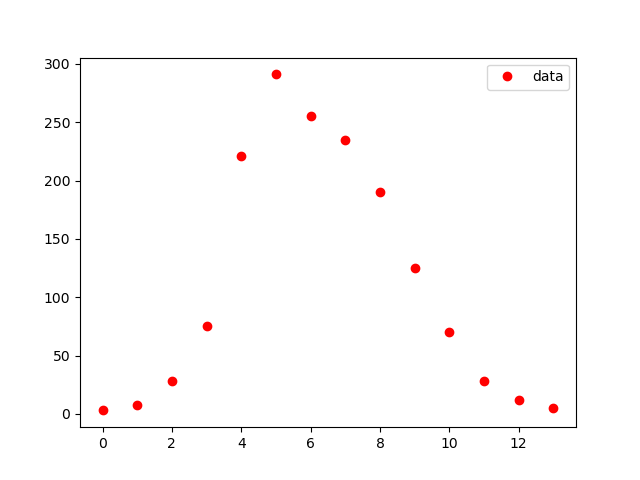

データは参考②のとおり、代入して以下のようにグラフに出力する。#show observed i #obs_i=np.loadtxt('fitting.csv') data_influ=[3,8,28,75,221,291,255,235,190,125,70,28,12,5] data_day = [1,2,3,4,5,6,7,8,9,10,11,12,13,14] obs_i = data_influ plt.plot(obs_i,"o", color="red",label = "data") plt.legend() plt.pause(1) plt.close()結果は以下のとおり、これは途中の確認のための出力なので見出しなどは省略している。

さて、次が推定部分である。この評価関数は引数の値を使って微分方程式で計算し、評価結果を返している。#function which estimate i from seir model func def estimate_i(ini_state,beta,lp,ip): v=odeint(seir_eq,ini_state,t,args=(beta,lp,ip)) est=v[0:int(t_max/dt):int(1/dt)] return est[:,2]対数尤度関数を以下のように定義する。

※参考①を参照

基本はパラメータを変更して、この対数尤度関数の最大値を求める問題になる。(実際はマイナスを取って最小化問題にしている)

※ここでlogの引数が負になるのを防ぐために絶対値を取っている#define logscale likelihood function def y(params): est_i=estimate_i(ini_state,params[0],params[1],params[2]) return np.sum(est_i-obs_i*np.log(np.abs(est_i)))最大値を求めるために以下のScipyのminimize関数を利用する。

#optimize logscale likelihood function mnmz=minimize(y,[beta,lp,ip],method="nelder-mead") print(mnmz)出力は以下のとおり

>python minimize_params.py final_simplex: (array([[6.87640764, 1.21966435, 2.01373196], [6.87636378, 1.21965986, 2.01373496], [6.87638203, 1.2196629 , 2.01372646], [6.87631916, 1.21964456, 2.0137297 ]]), array([-6429.40676091, -6429.40676091, -6429.40676091, -6429.4067609 ])) fun: -6429.406760912483 message: 'Optimization terminated successfully.' nfev: 91 nit: 49 status: 0 success: True x: array([6.87640764, 1.21966435, 2.01373196])計算結果から以下のようにbeta_const,lp,gamma_constを取り出し、以下でR0を計算する。これが基本再生産数であり、感染拡大の目安でありR0<1なら拡大しないが、R0>1なら拡大し、その程度を示す指標である。

#R0 beta_const,lp,gamma_const = mnmz.x[0],mnmz.x[1],mnmz.x[2] #感染率、感染待時間、除去率(回復率) print(beta_const,lp,gamma_const) R0 = beta_const*(1/gamma_const) print(R0)今回は以下のとおりとなり、R0=3.41なので感染拡大したわけですね。

6.876407637532918 1.2196643491443309 2.0137319643699927 3.4147581501415165こうして求めたものをグラフに表示します。

#plot reult with observed data fig, (ax1,ax2) = plt.subplots(2,1,figsize=(1.6180 * 4, 4*2)) lns1=ax1.plot(obs_i,"o", color="red",label = "data") lns2=ax1.plot(estimate_i(ini_state,mnmz.x[0],mnmz.x[1],mnmz.x[2]), label = "estimation") lns_ax1 = lns1+lns2 labs_ax1 = [l.get_label() for l in lns_ax1] ax1.legend(lns_ax1, labs_ax1, loc=0) lns3=ax2.plot(obs_i,"o", color="red",label = "data") lns4=ax2.plot(t,odeint(seir_eq,ini_state,t,args=(mnmz.x[0],mnmz.x[1],mnmz.x[2]))) ax2.legend(['data','Susceptible','Exposed','Infected','Recovered'], loc=0) ax2.set_title('SEIR_b{:.2f}_ip{:.2f}_gamma{:.2f}_N{:d}_E0{:d}_I0{:d}_R0{:.2f}'.format(beta_const,lp,gamma_const,N,E0,I0,R0)) plt.savefig('./fig/SEIR_b{:.2f}_ip{:.2f}_gamma{:.2f}_N{:d}_E0{:d}_I0{:d}_R0{:.2f}_.png'.format(beta_const,lp,gamma_const,N,E0,I0,R0)) plt.show() plt.close()結果は上記のとおりです。

・その他のモデル

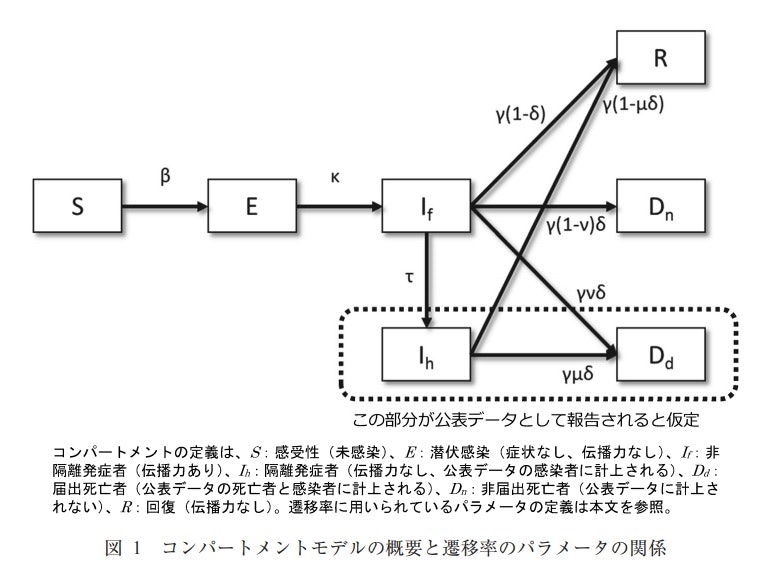

この計算をやっていたら、もう少し簡単なSIRモデルと少し複雑なモデルがあったのでまとめておきます。

SIRモデルは、S-E-I-RからExposureを無視したモデルなので以下のとおりです。{\begin{align} \frac{dS}{dt} &= -\beta \frac{SI}{N} \\ \frac{dI}{dt} &= \beta \frac{SI}{N} -\gamma I \\ \frac{dR}{dt} &= \gamma I \\ \end{align} }以下のように書き換えると$R_0$の意味が理解できる。

{\begin{align} \frac{dS}{dt} &= -R_0 \frac{S}{N} \frac{dR}{dt} \\ R_0 &= \frac{beta}{gamma}\\ \end{align} }一方、例えば死亡する遷移があり、届け出無しの死亡とかあるなど複雑な状況だと以下のようになります。なお、死亡者は感染には寄与しないという仮定です。

※COVID-19はこんな感じかもしれない

図は参考①の以下の文献より

・数理モデルを用いたエボラウイルス感染症の流行の解析

まとめ

・minimize@scipyにより自動的にデータフィッティングできるようになった

・SEIRモデルで実際のデータをフィッティング出来た・次回はCOVID-19の各国のデータを分析したいと思う

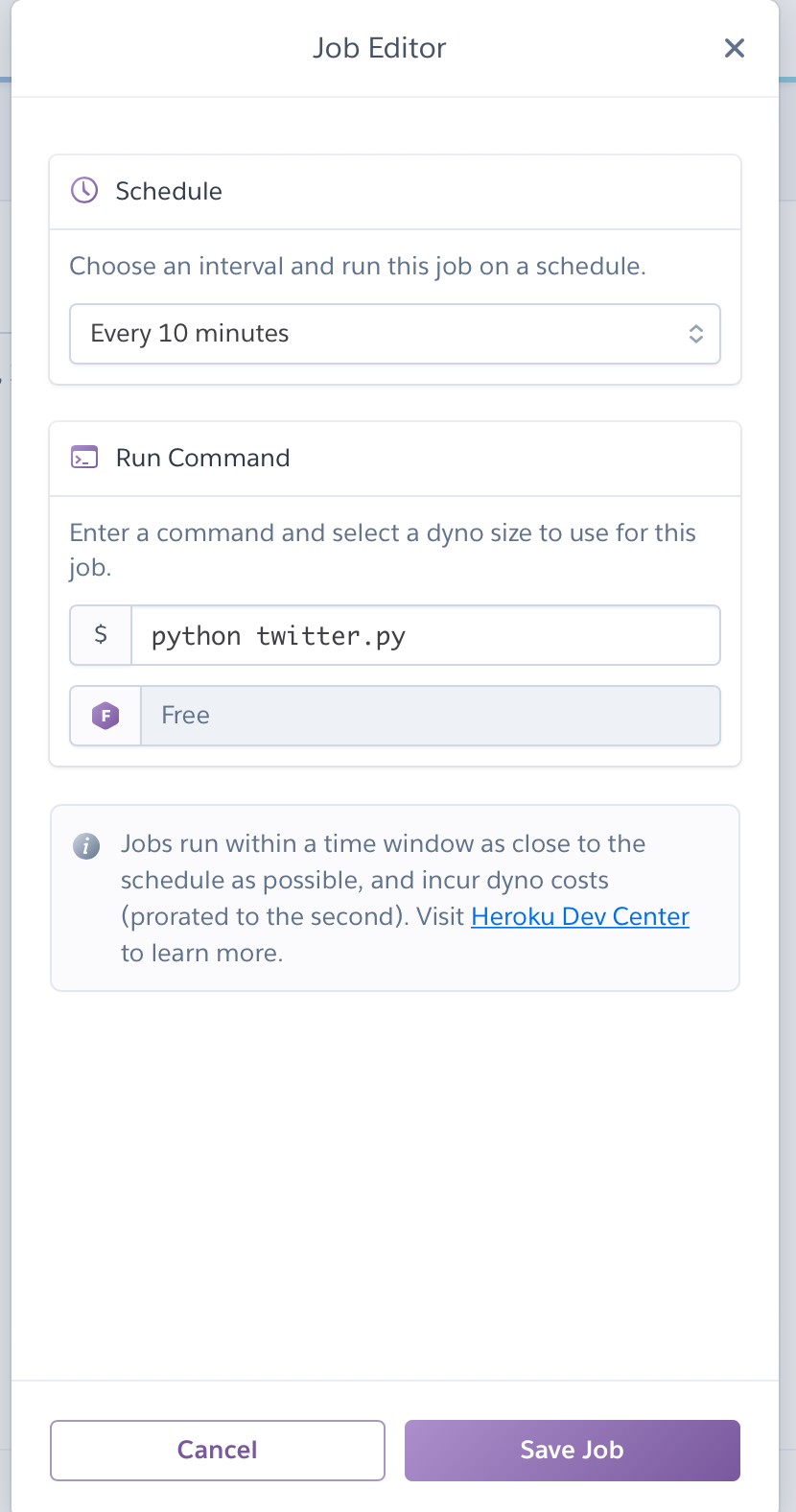

- 投稿日:2020-03-22T23:27:54+09:00

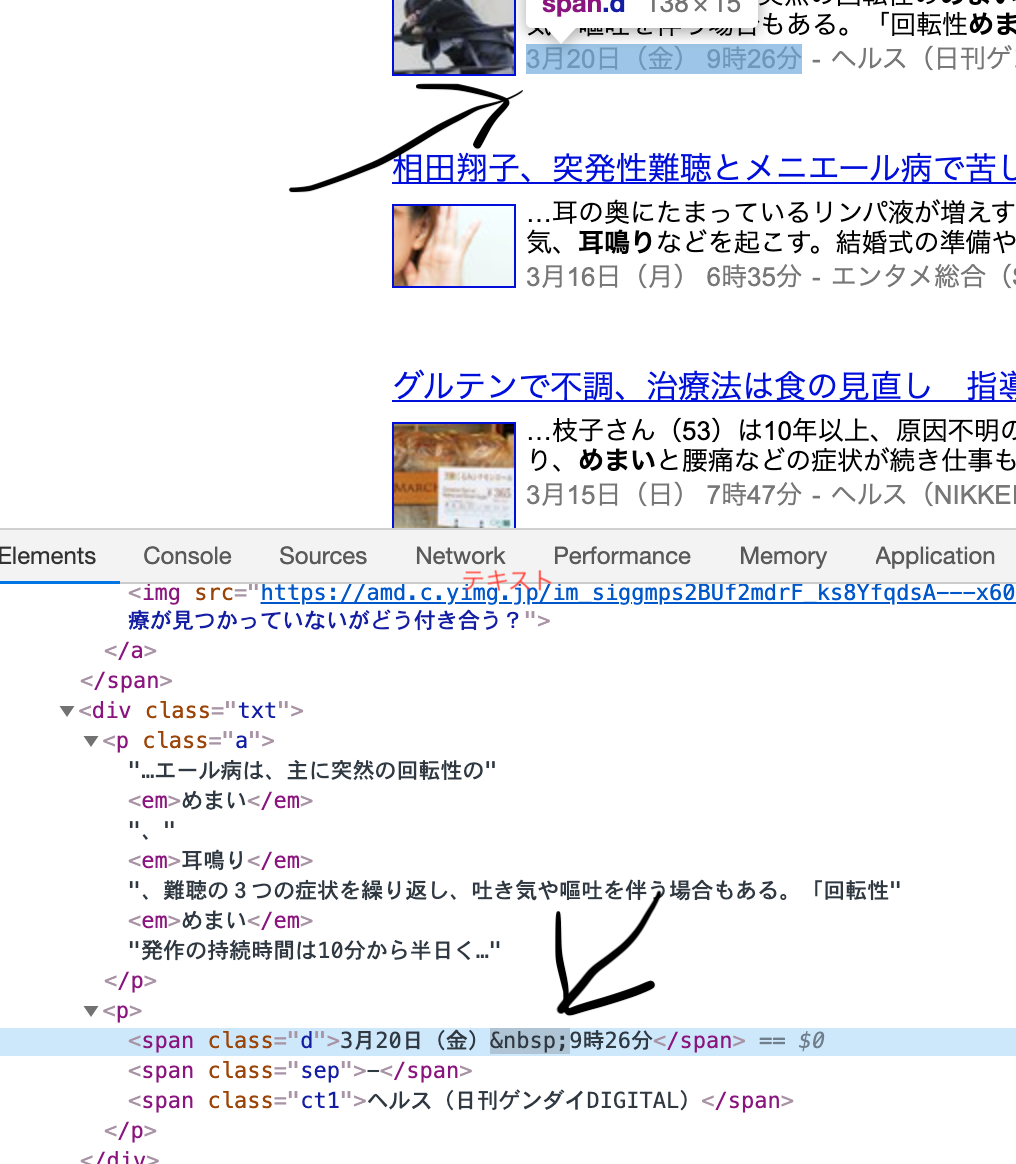

LineNotifyを使ってメッセージ、画像を送信する

LineNotifyを使って Fortniteの画像とメッセージを送ってみる。

まず、LINE Notifyのサイトでログインしてトークンを発行する。

https://notify-bot.line.me/ja/・Mac

・python(1)ディレクトリ構成

imagesの中に、gazo.jpegを保存。test ├test.py └images └gazo.img(2)test.pyを記述

コードは以下の通り。test.py#coding:UTF-8 import requests,os #------画像を送る場合---------------------------- def main_gazo(): url = "https://notify-api.line.me/api/notify" token = "*********************************" headers = {"Authorization" : "Bearer "+ token} message = 'Fortnite!' payload = {"message" : message} #imagesフォルダの中のgazo.jpg files = {"imageFile":open('images/gazo.jpeg','rb')} #rbはバイナリファイルを読み込む post = requests.post(url ,headers = headers ,params=payload,files=files) #------メッセージを送る場合---------------------------- def main(): url = "https://notify-api.line.me/api/notify" token = "*********************************" headers = {"Authorization" : "Bearer "+ token} message = 'Fortnite!' payload = {"message" : message} r = requests.post(url ,headers = headers ,params=payload) if __name__ == '__main__': main_gazo()#画像を送るmain_gazo()を動かしてみる(メッセージの場合はmain())

- 投稿日:2020-03-22T23:26:48+09:00

Pythonで毎日AtCoder #13

はじめに

今まではAtCoderProblemsのレコメンド問題を解いていましたが、より基礎的な力が足りないと思ったのでこれをやります。

#13

さすがにA問題1題だけだと物足りないので、A問題をふたつ解きます。

考えたこと

ABC086-Aは$a*b mod(2)$するだけa, b = map(int,input().split()) if a*b % 2 != 0: print('Odd') else: print('Even')ABC081-Aはsの中の'1'をcountするだけ

s = list(str(input())) print(s.count('1'))まとめ

今日のABCで悔しい思いをしたのでとりあえず過去問精選を解く。

では、また

- 投稿日:2020-03-22T23:06:15+09:00

AtCoder Beginner Contest 159 参戦記

AtCoder Beginner Contest 159 参戦記

ABC159A - The Number of Even Pairs

3分半で突破. 奇数のペアか、偶数のペアが答えになる. kC2 = k(k-1)/2 が分かっていればあとは書くだけなのだが、A問題にしては難しいね、これ.

N, M = map(int, input().split()) print(N * (N - 1) // 2 + M * (M - 1) // 2)ABC159B - String Palindrome

12分で突破. 時間かかりすぎた orz. 回分チェックルーチンを書いて、後は 1-indexed を 0-indexed に変換しながら、言われたとおりにチェックしていくだけ. B問題にしては難しいね、これ.

S = input() def is_palindrome(s): return s == s[::-1] N = len(S) if not is_palindrome(S): print('No') exit() if not is_palindrome(S[:(N - 1) // 2]): print('No') exit() if not is_palindrome(S[(N + 3) // 2 - 1:]): print('No') exit() print('Yes')ABC159C - Maximum Volume

2分で突破. A問題の間違いじゃないの、これ?

L = int(input()) print((L / 3) ** 3)ABC159D - Banned K

10分で突破. 当然 k 番目のボールを除いた場合の数を毎回全部計算し直していたら TLE. とりあえず抜かない場合の数を計算して、k 番目の値の場合の数だけ調整して答える.

N = int(input()) A = list(map(int, input().split())) d = {} for a in A: if a in d: d[a] += 1 else: d[a] = 1 s = 0 for k in d: s += d[k] * (d[k] - 1) // 2 for i in range(N): t = d[A[i]] print(s - t * (t - 1) // 2 + (t - 1) * (t - 2) // 2)ABC159E - Dividing Chocolate

敗退. 累積和でホワイトチョコの数え上げを O(HW) から O(H) に軽減して、再帰関数で総当りしたが、TLE & WA でした. 総当たりなのに WA なのでどこか実装がバグってますね…….

- 投稿日:2020-03-22T23:02:54+09:00

ブラックジャックの戦略を強化学習で作ってみる(①ブラックジャックの実装)

はじめに

Pythonと強化学習の勉強を兼ねて,ブラックジャックの戦略作りをやってみました.

ベーシックストラテジーという確率に基づいた戦略がありますが,それに追いつけるか試してみます.こんな感じで進めていきます

1. ブラックジャック実装 ← 今回はここ

2. OpenAI gymの環境に登録

3. 強化学習でブラックジャックの戦略を学習なぜブラックジャック?

- プログラミングの勉強によさそう(プログラミング入門者からの卒業試験は『ブラックジャック』を開発すべし)

- 学習後の戦略をベーシックストラテジーと比較できる(ベンチマークがある)

- ブラックジャックうまくなりたい

開発環境

- Windows 10

- Python 3.6.9

- Anaconda 4.3.0 (64-bit)

ブラックジャックのルール

ブラックジャックはカジノの中でも人気のテーブルゲームです.

簡単にルールを紹介します.基本ルール

- ディーラー対プレーヤーでカードを配布

- 手札の合計が21点に近い方が勝ち

- 手札の合計点が22点を超えると負け(バースト)

- ポイントの数え方

- 2~9・・・そのまま2~9点

- 10と絵札・・・10点

- A(エース)・・・1点または11点

実装するブラックジャックのルール

こんな感じのブラックジャックを作ります.

- トランプ6組を使用

- BET機能あり(ただし額は固定で$100.リターンは強化学習の報酬にします.)

- 初期の所持金は$1000

- Playerの選択肢

- スタンド(Stand)・・・カードを引かず勝負する

- ヒット(Hit)・・・もう一枚カードを引く

- ダブルダウン(Double Down)・・・BETを2倍にしてもう1枚だけカードを引く

- サレンダー(Surrender)・・・BETの半分を放棄してプレイを降りる

- 実装しないこと

- スプリット(Split)・・・配られた2枚のカードが同じ数字の場合,はじめのBETと同じ額を追加し2つに分けてプレイする

- インシュランス(Insurance)・・・ディーラーの表向きカードがAの時,BETの半分を追加して保険をかける

- ブラックジャック(BlackJack)・・・A+絵札or10の2枚で21点になること

実装

コード全体は末尾に記載します.

Cardクラス

トランプのカードを生成します.

ブラックジャックの特殊な絵札の点数の数え方はここで定義します.

Aも特殊なのですが,ここでは1点として生成します.

Aの点数はHandクラス内で他の手札の点数を考慮して決定します.class Card: ''' カードを生成 数字:A,2~10,J,Q,K スート:スペード,ハート,ダイヤ,クラブ ''' SUITS = '♠♥♦♣' RANKS = range(1, 14) # 通常のRank SYMBOLS = "A", "2", "3", "4", "5", "6", "7", "8", "9", "10", "J", "Q", "K" POINTS = [1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 10, 10, 10] # BlackJack用のポイント def __init__(self, suit, rank): self.suit = suit self.rank = rank self.index = suit + self.SYMBOLS[rank - self.RANKS[0]] self.point = self.POINTS[rank - self.RANKS[0]] def __repr__(self): return self.indexDeckクラス

NUM_DECK = 6と定義して,6組のトランプを使ったデッキを生成します.

デッキ生成と同時にシャッフルまでやってしまいます.class Deck: ''' カードがシャッフルされたデッキ(山札を生成) ''' def __init__(self): self.cards = [Card(suit, rank) \ for suit in Card.SUITS \ for rank in Card.RANKS] if NUM_DECK > 1: temp_cards = copy.deepcopy(self.cards) for i in range(NUM_DECK - 1): self.cards.extend(temp_cards) random.shuffle(self.cards) ・・・略Handクラス

手札へのカード追加やポイントの計算をします.

ソフトハンド(Aを含む手札)の判定も入れました.class Hand: """ 手札クラス """ def __init__(self): self.hand = [] self.is_soft_hand = False def add_card(self, card): # 手札にカードを加える処理. ・・・略 def check_soft_hand(self): # ソフトハンド(Aを含む手札)かチェックする ・・・略 def sum_point(self): # 手札のポイントを計算. # ソフトハンドなら,Aが1の場合と11の場合,両方計算する ・・・略 def calc_final_point(self): # Dealerと勝負するときのポイントを計算する # BUSTしていない最終的なポイントを返す ・・・略 def is_bust(self): # 手札がBUST(21を超えている)かどうか判定する ・・・略 def deal(self, card): # Deal時の処理 ・・・略 def hit(self, card): # Hit時の処理 ・・・略Playerクラス

StandやHitといった選択はここで定義します.

未実装のSplitやInsuranceも追記するならここへ.

おまけで自動プレイモードをつけました.後述の適当AIでプレイできます.class Player: def __init__(self): self.hand = Hand() self.chip = Chip() self.done = False # Playerのターン終了を示すフラグ self.hit_flag = False # Player が Hit を選択済みかどうか示すフラグ self.is_human = False # True:人がプレイ,False:自動プレイ def init_player(self): # 手札や各フラグを初期化する ・・・略 def deal(self, card): # Stand時の処理 ・・・略 def hit(self, card): # Hit時の処理 ・・・略 def stand(self): # Stand時の処理 ・・・略 def double_down(self, card): # Double down時の処理 ・・・略 def surrender(self): # Surrender時の処理 ・・・略Dealerクラス

Playerクラスと一緒でよかったかもしれません.

ディーラーならではのメソッドが必要かと思って作りましたが特にありませんでした.Chipクラス

勝負の後のチップのやり取り.

勝ったら賭けた額の2倍がもらえ,負けたら全額没収.引き分けなら賭けた分がそのままPlayerに戻ります.class Chip: def __init__(self): self.balance = INITIAL_CHIP self.bet = 0 def bet_chip(self, bet): self.balance -= bet self.bet = bet def pay_chip_win(self): self.balance += self.bet * 2 def pay_chip_lose(self): self.balance = self.balance def pay_chip_push(self): self.balance += self.betAIクラス

自動プレイ用の適当なAIが入っています.おまけ程度.

強化学習をする前のテスト用です.class AI: ・・・略 def select_random3(self, hand, n): if hand < 11: selection = 'h' # hit elif hand == 11 and n == 2: selection = 'd' # double down elif hand == 16 and n == 2: selection = 'r' # surrender elif hand > 17: selection = 's' # stand else: r = random.randint(0, 1) if r > 0.5: selection = 'h' # hit else: selection = 's' # stand return selectionGameクラス

ブラックジャックのメイン機能です.

表示関係のメソッドが混在していて見にくいかも.改善の余地ありです.

player_step関数は,gymのstep関数でも使います.class Game: def __init__(self): self.game_mode = 0 # 0:開始待ち,1:ゲーム中, 2:ゲーム終了 self.deck = Deck() self.player = Player() self.dealer = Dealer() self.judgment = 0 # 1:勝ち,0:引き分け, -1:負け self.game_count = 0 self.start() self.message_on = True #self.player.is_human # True:コンソールにメッセージ表示する,False:コンソールにメッセージ表示しない def start(self): # デッキをシャッフル,Player, Dealerを初期化 ・・・略 def reset_game(self): # Player, Dealerの手札をリセット ・・・略 def bet(self, bet): # PlayerがBETする ・・・略 def deal(self, n=2): # Player, Dealerにカードを配る ・・・略 def player_turn(self): # Playerのターン.行動をコンソールから入力する or 適当AIで自動決定する ・・・略 def player_step(self, action): # Stand, Hit, Double down, Surrenderに応じた処理 ・・・略 def show_card(self): # カードを表示.Dealerの伏せられているカードは「?」表示 ・・・略 def dealer_turn(self): # Dealerのターン.ポイントが17以上になるまでカードを引く ・・・略 def open_dealer(self): # Dealerの伏せられていたカードをオープンする ・・・略 def judge(self): # 勝敗の判定 ・・・略 def pay_chip(self): # Chipの精算 ・・・略 def check_chip(self): # Playerの所持額がMinimum Bet(最低限賭けなければいけない額)を下回っていないかチェック # 下回っていたらゲームを終了する ・・・略 def show_judgement(self): # 勝敗の結果を表示 ・・・略 def ask_next_game(self): # ゲームを続けるか尋ねる ・・・略 def check_deck(self): # カードの残り枚数をチェックし,少なければシャッフルする ・・・略main関数

main関数にゲームの流れに沿った処理を書きます.

これを実行するとブラックジャックで遊べます.

ちなみに,

・ NUM_DECK = 6 # デッキ数

・ INITIAL_CHIP = 1000 # 初期チップ

・ MINIMUM_BET = 100 # 最低限賭けなければいけない額

としています.def main(): game = Game() game.start() while game.game_mode == 1: game.reset_game() # いろいろをリセットする game.bet(bet=100) # 賭ける game.deal() # カードを配る game.player_turn() # プレイヤーのターン game.dealer_turn() # ディーラーのターン game.judge() # 勝敗の判定 game.pay_chip() # チップの精算 game.check_chip() # プレイヤーの残額を確認 game.ask_next_game() # ゲームを続けるか尋ねる game.check_deck() # 残りカード枚数の確認 print("BlackJackを終了します") print(str(game.game_count) + "回ゲームをしました") return game.player.chip, game.game_count実行結果

Hit(h) or Stand(s) or Double down(d) or Surrender(r):の後に,

キーボードから文字を入力してPlayerの選択を決めます.$100 賭けました 残りは $900 Playerのターン Player : [♠A, ♦9] = [10, 20], soft card : True Dealer : ♣6, ? = 6 Hit(h) or Stand(s) or Double down(d) or Surrender(r): s Dealerのターン Player : [♠A, ♦9] = 20 Dealer : [♣6, ♥K] = 16 Dealerのターン Player : [♠A, ♦9] = 20 Dealer : [♣6, ♥K, ♥3] = 19 Playerの勝ち Playerの所持チップは $1100 続けますか? y/n: y 残りカード枚数は 307 $100 賭けました 残りは $1000 Playerのターン Player : [♠2, ♥K] = [12], soft card : False Dealer : ♥3, ? = 3 Hit(h) or Stand(s) or Double down(d) or Surrender(r): h Playerのターン Player : [♠2, ♥K, ♥2] = [14], soft card : False Dealer : ♥3, ? = 3 Hit(h) or Stand(s) or Double down(d) or Surrender(r): h Playerのターン Player : [♠2, ♥K, ♥2, ♠Q] = [24], soft card : False Dealer : ♥3, ? = 3 Player BUST Playerの負け Playerの所持チップは $1000 続けますか? y/n: y 残りカード枚数は 301 $100 賭けました 残りは $900 Playerのターン Player : [♥7, ♥5] = [12], soft card : False Dealer : ♠8, ? = 8 Hit(h) or Stand(s) or Double down(d) or Surrender(r): d Playerのターン Player : [♥7, ♥5, ♠8] = [20], soft card : False Dealer : ♠8, ? = 8 Double down が選択されました.掛け金を倍にしました 残りは $800 Dealerのターン Player : [♥7, ♥5, ♠8] = 20 Dealer : [♠8, ♥2] = 10 Dealerのターン Player : [♥7, ♥5, ♠8] = 20 Dealer : [♠8, ♥2, ♣7] = 17 Playerの勝ち Playerの所持チップは $1200 続けますか? y/n: n 残りカード枚数は 295 BlackJackを終了します 3回ゲームをしましたコード

記録用に置いておきます.

以下コード(クリックで展開)

blackjack.pyimport random import copy # 定数 NUM_DECK = 6 # デッキ数 NUM_PLAYER = 1 # プレイヤー数 INITIAL_CHIP = 1000 # 初期チップ MINIMUM_BET = 100 class Card: ''' カードを生成 数字:A,2~10,J,Q,K スート:スペード,ハート,ダイヤ,クラブ ''' SUITS = '♠♥♦♣' RANKS = range(1, 14) # 通常のRank SYMBOLS = "A", "2", "3", "4", "5", "6", "7", "8", "9", "10", "J", "Q", "K" POINTS = [1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 10, 10, 10] # BlackJack用のポイント def __init__(self, suit, rank): self.suit = suit self.rank = rank self.index = suit + self.SYMBOLS[rank - self.RANKS[0]] self.point = self.POINTS[rank - self.RANKS[0]] def __repr__(self): return self.index class Deck: ''' カードがシャッフルされたデッキ(山札を生成) ''' def __init__(self): self.cards = [Card(suit, rank) \ for suit in Card.SUITS \ for rank in Card.RANKS] if NUM_DECK > 1: temp_cards = copy.deepcopy(self.cards) for i in range(NUM_DECK - 1): self.cards.extend(temp_cards) random.shuffle(self.cards) def draw(self, n=1): ''' デッキから指定した枚数分だけ引く関数 ''' cards = self.cards[:n] del self.cards[:n] # 引いたカードを山札から削除 return cards def shuffle(self): ''' デッキをシャッフルする ''' random.shuffle(self.cards) return def count_cards(self): """ デッキの残り枚数を返す """ count = len(self.cards) return count class Hand: """ 手札クラス """ def __init__(self): self.hand = [] self.is_soft_hand = False def add_card(self, card): self.hand.append(card) def check_soft_hand(self): """ ソフトハンド(Aを含むハンド)かチェックする """ hand_list = [] for i in range(len(self.hand)): hand_list.append(self.hand[i].point) hand_list.sort() # 手札を昇順にソート if hand_list[0] == 1 and sum(hand_list[1:]) < 11: # ソフトハンドなら self.is_soft_hand = True else: self.is_soft_hand = False def sum_point(self): """ ポイントの合計値を返す """ self.check_soft_hand() hand_list = [] for i in range(len(self.hand)): hand_list.append(self.hand[i].point) hand_list.sort() # 手札を昇順にソート s1 = 0 # Aを1とカウントする場合の初期値 for i in range(len(self.hand)): s1 += self.hand[i].point if self.is_soft_hand == True: # ソフトハンドなら s2 = 11 # 1枚目のAを11としてカウント for i in range(len(hand_list)-1): s2 += hand_list[i+1] s = [s1, s2] else: s = [s1] return s def calc_final_point(self): """ BUSTしていない最終的なポイントを返す """ temp_point = self.sum_point() if max(temp_point) > 22: p = temp_point[0] # ポイントの大きい方がBUSTなら小さい方 else: p = max(temp_point) return p def is_bust(self): """ BUSTかどうか判定する """ if min(self.sum_point()) > 21: # ポイントの小さい方が21を超えていたら return True else: return False def deal(self, card): """ Dealされたカードを手札に加える """ for i in range(len(card)): self.add_card(card[i]) def hit(self, card): # 1枚ずつHitする if len(card) == 1: self.add_card(card[0]) else: print("カードの枚数が正しくありません") class Player: def __init__(self): self.hand = Hand() self.chip = Chip() self.done = False # Playerのターン終了を示すフラグ self.hit_flag = False # Player が Hit を選択済みかどうか示すフラグ self.is_human = True # True:人がプレイ,False:自動プレイ def init_player(self): self.hand = Hand() self.done = False self.hit_flag = False def deal(self, card): self.hand.deal(card) def hit(self, card): # カードを1枚手札に加える self.hand.hit(card) self.hit_flag = True def stand(self): # ターン終了 self.done = True def double_down(self, card): # betを2倍にして一度だけHitしてターン終了 self.chip.balance -= self.chip.bet self.chip.bet = self.chip.bet * 2 self.hand.hit(card) self.done = True # double down後は一度しかhitできないルールとする def surrender(self): # Betを半分にして(betの半分を手持ちに戻して)ターン終了 # self.chip.balance += int(self.chip.bet / 2) self.chip.bet = int(self.chip.bet / 2) self.chip.balance += self.chip.bet self.done = True def insurance(self): # 未実装 pass def split(self): # 未実装 pass class Dealer: def __init__(self): self.hand = Hand() def init_dealer(self): self.hand = Hand() def deal(self, card): self.hand.deal(card) def hit(self, card): self.hand.hit(card) class Chip: def __init__(self): self.balance = INITIAL_CHIP self.bet = 0 def bet_chip(self, bet): # Chipを掛けたら手持ちから減らす self.balance -= bet self.bet = bet def pay_chip_win(self): # 勝った時,BETの2倍を得る self.balance += self.bet * 2 def pay_chip_lose(self): # 負けた時,BETを全額失う self.balance = self.balance def pay_chip_push(self): # 引き分けのとき,BETした分だけ戻る self.balance += self.bet class AI: def select_random1(self): r = random.randint(0, 1) if r > 0.5: selection = 'h' # hit else: selection = 's' # stand return selection def select_random2(self, hand): if hand <= 11: selection = 'h' else: r = random.randint(0, 1) if r > 0.5: selection = 'h' # hit else: selection = 's' # stand return selection def select_random3(self, hand, n): if hand < 11: selection = 'h' # hit elif hand == 11 and n == 2: selection = 'd' # double down elif hand == 16 and n == 2: selection = 'r' # surrender elif hand > 17: selection = 's' # stand else: r = random.randint(0, 1) if r > 0.5: selection = 'h' # hit else: selection = 's' # stand return selection class Game: def __init__(self): self.game_mode = 0 # 0:開始待ち,1:ゲーム中, 2:ゲーム終了 self.deck = Deck() self.player = Player() self.dealer = Dealer() self.judgment = 0 self.game_count = 0 self.start() self.message_on = True #self.player.is_human # True:コンソールにメッセージ表示する,False:コンソールにメッセージ表示しない def start(self): self.deck.shuffle() self.game_mode = 1 self.player = Player() self.dealer = Dealer() self.game_count = 0 def reset_game(self): self.player.init_player() self.dealer.init_dealer() self.game_count += 1 def bet(self, bet): self.player.chip.bet_chip(bet=bet) if self.message_on: print("$" + str(self.player.chip.bet) + " 賭けました") print("残りは $" + str(self.player.chip.balance)) # カードを配る def deal(self, n=2): ''' カードを配る ''' card = self.deck.draw(n) self.player.deal(card) # print(self.player.hand.hand) card = self.deck.draw(n) self.dealer.deal(card) # print(self.dealer.hand.hand) self.judgment = 0 # 勝敗の判定 self.player.done = False self.show_card() # Playerのターン def player_turn(self): ''' プレーヤーのターン ''' if self.player.hand.calc_final_point() == 21: # 合計が21だったらすぐにDealerのターンへ self.player.done = True while not self.player.done and not self.player.hand.is_bust(): if self.player.is_human is True: action = input("Hit(h) or Stand(s) or Double down(d) or Surrender(r): ") elif self.player.is_human is True and self.player.hit_flag: action = input("Hit(h) or Stand(s): ") # Hitの後はhit/standのみ else: action = AI().select_random3(hand=self.player.hand.calc_final_point(), n=len(self.player.hand.hand)) self.player_step(action=action) def player_step(self, action): if action == 'h': # Hit card = self.deck.draw(1) self.player.hit(card) self.show_card() if self.player.hand.calc_final_point() == 21: # 合計点が21になったらこれ以上Hitはできない self.player.done = True if self.player.hand.is_bust(): self.player.done = True self.judgment = -1 # PlayerがBUSTしたら即負け if self.message_on: print("Player BUST") elif action == 's': # Stand self.player.stand() elif action == 'd' and self.player.hit_flag is False: # Double down. Hit選択していない場合に可 card = self.deck.draw(1) if self.player.chip.balance >= self.player.chip.bet: # 残額が賭けた額以上にあればDouble Down可 self.player.double_down(card) self.show_card() if self.message_on: print("Double down が選択されました.掛け金を倍にしました") print("残りは $" + str(self.player.chip.balance)) if self.player.hand.is_bust(): self.player.done = True self.judgment = -1 # PlayerがBUSTしたら即負け if self.message_on: print("Player BUST") else: # 残額が賭けた額未満ならばHitとする print("チップが足りないためHitします") self.player.hit(card) self.show_card() if self.player.hand.calc_final_point() == 21: # 合計点が21になったらこれ以上Hitはできない self.player.done = True if self.player.hand.is_bust(): self.player.done = True self.judgment = -1 # PlayerがBUSTしたら即負け if self.message_on: print("Player BUST") elif action == 'r' and self.player.hit_flag is False: # Surrender. Hit選択していない場合に可 self.player.surrender() self.judgment = -1 # Surrenderを選択したので負け if self.message_on: print("Surrender が選択されました") else: if self.message_on: print("正しい選択肢を選んでください") def show_card(self): ''' プレーヤーのカードを表示 ''' if self.message_on: print("Playerのターン") print("Player : " + str(self.player.hand.hand) + " = " + str(self.player.hand.sum_point()) + ", soft card : " + str(self.player.hand.is_soft_hand)) print("Dealer : " + str(self.dealer.hand.hand[0].index) + ", ? = " + str(self.dealer.hand.hand[0].point)) else: pass def dealer_turn(self): ''' ディーラーのターン ''' if self.judgment == -1: return self.open_dealer() while self.dealer.hand.calc_final_point() < 17 and self.judgment == 0: card = self.deck.draw(1) self.dealer.hit(card) self.open_dealer() if self.dealer.hand.calc_final_point() > 21: self.judgment = 1 if self.message_on: print("Dealer BUST") def open_dealer(self): ''' hole cardをオープンする ''' if self.message_on: print("Dealerのターン") print("Player : " + str(self.player.hand.hand) + " = " + str(self.player.hand.calc_final_point())) print("Dealer : " + str(self.dealer.hand.hand) + " = " + str(self.dealer.hand.calc_final_point())) else: pass def judge(self): ''' 勝敗の判定 ''' if self.judgment == 0 and self.player.hand.calc_final_point() > \ self.dealer.hand.calc_final_point(): self.judgment = 1 elif self.judgment == 0 and self.player.hand.calc_final_point() < \ self.dealer.hand.calc_final_point(): self.judgment = -1 elif self.judgment == 0 and self.player.hand.calc_final_point() == \ self.dealer.hand.calc_final_point(): self.judgment = 0 if self.message_on: self.show_judgement() def pay_chip(self): previous_chip = self.player.chip.balance if self.judgment == 1: # Player win self.player.chip.pay_chip_win() elif self.judgment == -1: # Player lose self.player.chip.pay_chip_lose() elif self.judgment == 0: # Push self.player.chip.pay_chip_push() if self.message_on: print("Playerの所持チップは $" + str(self.player.chip.balance)) reward = self.player.chip.balance - previous_chip # このゲームで得た報酬 return reward def check_chip(self): if self.player.chip.balance < MINIMUM_BET: self.game_mode = 2 if self.message_on: print("チップがMinimum Betを下回ったのでゲームを終了します") def show_judgement(self): ''' 勝敗の表示 ''' if self.message_on: print("") if self.judgment == 1: print("Playerの勝ち") elif self.judgment == -1: print("Playerの負け") elif self.judgment == 0: print("引き分け") print("") else: pass def ask_next_game(self): ''' ゲームを続けるか尋ねる ''' if self.player.is_human == True: while self.game_mode == 1: player_input = input("続けますか? y/n: ") if player_input == 'y': break elif player_input == 'n': self.game_mode = 2 break else: print('y/nを入力してください') else: pass # 自動プレイなら継続する print('残りカード枚数は ' + str(self.deck.count_cards())) print("") def check_deck(self): ''' カードの残り枚数をチェックし,少なければシャッフルする ''' if self.deck.count_cards() < NUM_PLAYER * 10 + 5: self.deck = Deck() if self.message_on: print("デッキを初期化しました") print('残りカード枚数は ' + str(self.deck.count_cards())) print("") def main(): game = Game() game.start() while game.game_mode == 1: game.reset_game() # いろいろをリセットする game.bet(bet=100) # 賭ける game.deal() # カードを配る game.player_turn() # プレイヤーのターン game.dealer_turn() # ディーラーのターン game.judge() # 勝敗の判定 game.pay_chip() # チップの精算 game.check_chip() # プレイヤーの残額を確認 game.ask_next_game() # ゲームを続けるか尋ねる game.check_deck() # 残りカード枚数の確認 print("BlackJackを終了します") print(str(game.game_count) + "回ゲームをしました") return game.player.chip, game.game_count if __name__ == '__main__': main()終わりに

Pythonでブラックジャックを作ってみました.

ベーシックストラテジーになるべく近づけるため,Double downとSurrenderの実装にも挑戦してみました.

Splitもいつか入れたいです.

学習することを想定してBET機能を入れましたが,所持金がゼロなのにDouble downしてしまうなど,

バグが多々発見され,修正が大変でした.(まだバグがあったらご指摘ください)次は今回作ったブラックジャックを自作の環境として, OpenAI のgymに登録します.

参考にさせていただいたサイト

- 投稿日:2020-03-22T23:00:52+09:00

PythonでABC159を解きたかった

はじめに

今回は問題が簡単だったのでA~Cは解けましたが、Dまで解けるべきでした。

A問題

考えたこと

偶数を作るには、偶数+偶数、奇数+奇数しかないのでNとMのそれぞれで$_nC _r$、$_mC _r$しています。コンビネーションの計算は自分で実装してもいいですが、scipyにあるのでそれを使いました。from scipy.misc import comb n, m = map(int,input().split()) ans = comb(n,2,exact=True) + comb(m,2,exact=True) #exact=Trueで整数値が返される print(ans)B問題

考えたこと

回文の問題が苦手でA解いた後に放置していました。Sが回文であるのなら、s.reverse()==sになることを利用して解きました。強い回文の条件はsをスライスして、上と同じことをしました。ns = list(str(input())) checker = 0 n = len(s) new_s = list(reversed(s)) if s == new_s: checker += 1 split_s = s[0:(n-1)//2] new_s = list(reversed(split_s)) if new_s == split_s: checker += 1 split_s = s[(n+2)//2:n] new_s = list(reversed(split_s)) if new_s == split_s: checker += 1 if checker == 3: print('Yes') else: print('No')C問題

考えたこと

体積が最大になるのは、立方体になるときなので$(L/3)^3$で終わり。精度が怖かったけどなにもしなくても通った。l = int(input()) print((l/3)**3)D問題

問題

1WA、4TLE考えたこと

解けなかった

for文で$A_i$を抜いたAでコンビネーションを計算しようとしたけど、TLEが出て死んだ。from scipy.misc import comb n = int(input()) a = list(map(int,input().split())) a_s = set(a) for i in range(n): l = a[i] a[i] = 'X' ans = 0 for j in a_s: ans += comb(a.count(j),2,exact=True) print(ans) a[i] = lまとめ

勉強不足なのとBを解くことをあきらめてしまったことが敗因。

おやすみなさい。

- 投稿日:2020-03-22T23:00:51+09:00

Python の lambda の使い方

はじめに

lambda と聞くと AWS の lambda を思い付くかと思いますが、

今回はお話しするのは Python の無名関数を意味する lambda についてです。Python の lambda とは

ざっくり一言で表すと、def 文を使用せずに関数を定義できるものです。

def 文では以下のような構成になっているかと思います。

def function(引数): return 式lambda では以下のように記述することができます。

function = lambda 引数: 式使い方

この lambda の使い方について記述します。

def 文

まずは lambda を使用せずに def 文でプログラムを作成したいと思います。

内容としては小文字、大文字のアルファベットが入ったリストを用意して、

capitalize関数を用いて、全て大文字に修正するといったものです。l = ['A', 'b', 'C', 'd', 'e', 'F', 'g'] def change_words(words, func): for word in words: print(func(word)) def sample_func(word): return word.capitalize() change_words(l, sample_func)

change_words関数では

引数には words と function を渡す func を設定しています。

中の処理では words を for ループで回してあげてその値を func() の中に入れています。

funcの定義にしたがって、 word を変更するといった内容になります。

sample_func関数では

word を引数にしていて、中では capitalize() という文字列の先頭を

大文字にするメソッドを使用して返すといった処理になっています。実際に実行してみると全て大文字になって出力されることが確認できます。

A B C D E F Glambda

上記のプログラムを lambda を使用して記述してみます。

l = ['A', 'b', 'C', 'd', 'e', 'F', 'g'] def change_words(words, func): for word in words: print(func(word)) #def sample_func(word): # return word.capitalize() sample_func = lambda word: word.capitalize() change_words(l, sample_func)このように一行で記述することが可能になります。

実行してみると同様の結果が出力されると思います。lambda式には名前を付けない方がいい

今回はわかりやすいように lambda の式に

sample_funcと名前をつけましたが、Python のコーディング規約PEP8では

名前を付けて関数を定義する場合はdefを使うべきと推奨されています。そこで名前を付けずに、直接記述して関数として渡すことが可能です。

l = ['A', 'b', 'C', 'd', 'e', 'F', 'g'] def change_words(words, func): for word in words: print(func(word)) # def sample_func(word): # return word.capitalize() # sample_func = lambda word: word.capitalize() change_words(l, lambda word: word.capitalize())この記述だと関数をいちいち定義せずに使用でき、

キレイなプログラムになると思います。より効率的に

より lambda の効果を実感するために

今度はアルファベットを小文字に修正する関数を追加してみます。def 文

まずは def 文で記述してみます。

l = ['A', 'b', 'C', 'd', 'e', 'F', 'g'] def change_words(words, func): for word in words: print(func(word)) def sample_func(word): return word.capitalize() def sample_func2(word): return word.lower() change_words(l, sample_func) change_words(l, sample_func2)

sample_func2という名前で新たに関数を増やしました。実際に実行してみると小文字のアルファベットも出力されます。

A B C D E F G a b c d e f g

sample_func2関数の内容としては

capitalize()がlower()に変更しただけです。しかし、いちいち関数を定義してから記述しなければならないのは面倒に感じます。

lambda

そこで lambdaを使用して1行で記述した方が楽になります。

l = ['A', 'b', 'C', 'd', 'e', 'F', 'g'] def change_words(words, func): for word in words: print(func(word)) change_words(l, lambda word: word.capitalize()) change_words(l, lambda word: word.lower())こちらを実行しても同じ結果が出力されます。

おわりに

function を引数にするものは lambda を使用して()内で定義すれば

あえて def で関数を定義しなくてもよくなるため

とても効率のよいプログラムを記述することが可能になります。

- 投稿日:2020-03-22T22:42:45+09:00

Splunkでカスタムサーチコマンドを作成する

Splunkのサーチバーで使うコマンドが自作できると聞いたので試してみました。ちなみに、Splunkでは自作したコマンドを「カスタムサーチコマンド」と呼ぶらしい。

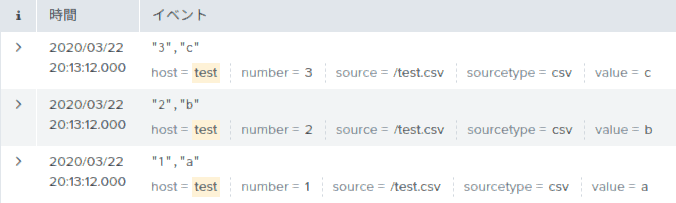

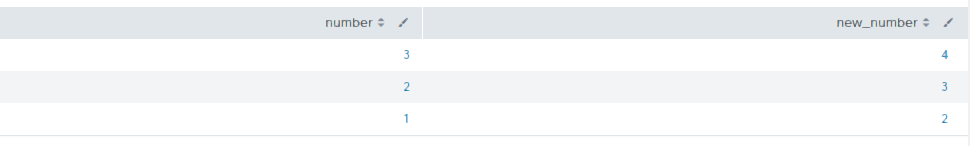

作成するカスタムサーチコマンドのイメージ

今回作成するカスタムサーチコマンドは、新規フィールド

new_numberを作成して、その値に「別フィールドnumberに書かれている値に1を加えた数」を入れる、というものにしました。今回使用する元データを下に示します。カスタムサーチコマンドを登録する

プログラムを作成する前にまず登録を行います。登録するには、

/opt/splunk/etc/apps/search/local/commands.confに以下のような文を追加します。Splunkの初回インストールの直後は、

/opt/splunk/etc/apps/search/配下にlocalフォルダすらないので、localフォルダを作成しcommands.confも新規作成します。/opt/splunk/etc/apps/search/local/commands.conf[hoge] filename = test.py streaming = true[ ]で囲まれた中の文字がサーチバーで記載するカスタムサーチコマンド名になり、このコマンドが呼び出されると

filename=で書かれているプログラム名を実行します。カスタムサーチコマンドの本体の作成

プログラムの本体は

/opt/splunk/etc/apps/search/bin/のフォルダに作成します。プログラム名はcommands.confに記入したプログラム名test.pyと同じにします。/opt/splunk/etc/apps/search/bin/test.pyimport splunk.Intersplunk data,dummy1,dummy2 = splunk.Intersplunk.getOrganizedResults(input_str=None) for tmp in data: tmp['new_number'] = int(tmp['number']) + 1 splunk.Intersplunk.outputResults(data)作成が完了したら、splunkの設定からSplunkを再起動します。

test.pyは再起動しなくても変更が反映されますが、commands.confは再起動しないと変更が反映されません。プログラムの実行

下のSPLを実行すると、

host = test | hoge | table number new_numberちなみにカスタムサーチコマンドは、前のSPLの結果を50件くらいに小分けして受け取っているようです。つまり、プログラムを起動し最初の50件を処理し終了したら、またプログラムを起動し次の50件を処理し終了する・・・を繰り返しているみたいです。だから、出力結果がビロビロ〜ンと伸びていくんですね。

おわりに

ちょこっとだけ調べたのですが、関数

splunk.Intersplunk.getOrganizedResultsで受け取るデータはpython標準のリスト型で、そのリスト型の中身はsplunk.util.OrderedDictで、標準の辞書型ではありませんでした。もう少し詳しく調べましたら、また投稿したいと思います。

動作環境

Ubuntu 18.04.4 LTS

Splunk 8.0.2.1

- 投稿日:2020-03-22T22:42:07+09:00

「〇〇で歌ってみた」動画のパワポ素材をpythonで生成する

概要

「〇〇で歌ってみた」動画の素材として用いることを想定し、本来の歌詞、替え歌歌詞、対応する画像を決まった場所に配置した画像をPowerPointのスライドとして生成するpythonコードを書きました。

背景

特定ジャンルの名詞だけで本来の歌詞を再現するように歌った替え歌を、通称「〇〇で歌ってみた」シリーズとよびます。

「〇〇で歌ってみた」動画では、本来の歌詞、替え歌歌詞、対応する画像を決まった場所に配置した下記のような画像を、紙芝居形式で流す事が多いです。

替え歌歌詞に登場する名詞数が多いときは対応する動画素材を手動で作るのが大変なので、プログラムで自動化したいと思いました。

またプログラムで生成したものを人が微調整できるようしておけば更に便利だと思ったので、PowerPointのスライドとして、作ることにしました。

このために、python-pptxというpythonからpptxファイルを生成できるライブラリを使いました。環境

macOS Catalina バージョン10.15.3

python3.8.0またはpython3.7.0用意するもの

画像ファイル

パワーポイントに挿入する画像を用意します。

今回はこちらの方法で入手した国旗画像を使います。名詞と画像ファイル名の対応表

名詞IDと対応する画像ファイル名をカンマ区切りで下記のように記入したcsvファイルを用意します。名詞IDは後述の歌詞定義ファイル中で使用します。

img_file_names.csvアイスランド,Flag_of_Iceland.png アイルランド,Flag_of_Ireland.png アゼルバイジャン,Flag_of_Azerbaijan.png アフガニスタン,Flag_of_Afghanistan.png アブハジア,Flag_of_the_Republic_of_Abkhazia.png アメリカ合衆国,Flag_of_the_United_States.png アラブ首長国連邦,Flag_of_the_United_Arab_Emirates.png アルジェリア,Flag_of_Algeria.png ...歌詞定義ファイル

本来の歌詞、替え歌歌詞、表示する画像の名詞IDをカンマ区切りで1行に1つずつ記入した下記のようなcsvを用意します。

名詞IDの部分はファイル名をいちいち書くのが手間だと感じたので、名詞IDをファイル名に置き換える対応表を別途用意する形式にしました。

画像ファイル名を直接書くのでも構わない場合は、対応表なしでも構いません。lyric.csv風の中のスバル,カザフスタン ツバル,カザフスタン 風の中のスバル,カザフスタン ツバル,ツバル 砂の中の銀河,スワジランド ギニア,スワジランド 砂の中の銀河,スワジランド ギニア,ギニア みんなどこへ行った,インドネシア インド,インドネシア みんなどこへ行った,インドネシア インド,インド 見守られることもなく,マリ モナコ レソト モナコ,マリ共和国 見守られることもなく,マリ モナコ レソト モナコ,モナコ 見守られることもなく,マリ モナコ レソト モナコ,レソト 見守られることもなく,マリ モナコ レソト モナコ,モナコ ...ファイル構成

画像ファイルを格納するフォルダ名をpictures、名詞と画像ファイル名の対応表をimg_file_names.csv、歌詞定義ファイルをlyric.csvとします。

またパワポを生成するpythonスクリプトをgenerate_pptx.pyとします。

これらのファイルを下記のように配置してください。. ├── generate_pptx.py ├── pitcures │ ├── Flag_of_Afghanistan.png │ ├── Flag_of_Albania.png │ └── ... ├── img_file_names.csv ├── lyric.csvコード

前述のファイル構成において、「〇〇で歌ってみた」動画の素材となるパワーポイントファイルを出力するpythonスクリプトについて説明します。コード全体は末尾に載せておきます。本コードを基本として編集することで、文字や画像の追加、配置の変更などもできます。必要に応じてpython-pptxの公式ドキュメントも参照してください。

ライブラリのインストール

python-pptxとPillowを使いますので、必要に応じて下記コマンド等によりインストールしてください。

pip install python-pptx pip install Pillowimportと各種定数の設定

ライブラリのimportと各種定数の設定をします。

スライドサイズは単位がEnglish Metric Unit (EMU; 1 cm = 360,000 emu) であることに注意してください。

(参考:python-pptxでスライドのサイズを変えたい)from pptx import Presentation from pptx.util import Inches, Pt from pptx.enum.text import PP_ALIGN from PIL import Image from pptx.dml.color import RGBColor #スライドサイズ #4:3 (default) 9144000x6858000 #16:9 12193200x6858000 SLIDE_WIDTH = 12193200 SLIDE_HEIGHT = 6858000 BACKGROUD_RGB = RGBColor(0,0,0) FONT_RGB = RGBColor(255,255,255) OUTPUT_FILE_PATH = "test.pptx" #替え歌歌詞テキストボックスの左上座標の高さ (左右方向は中央揃えするので不要) IMG_FILE_PATH = "img_file_names.csv"#1行につきidと画像パスがひとつずつ書かれたcsvファイル IMG_DIR = "./picture/" LYRIC_FILE_PATH = "lyric.csv"#1行につき本来の歌詞、替え歌歌詞、画像ファイルIDが一つずつ書かれたcsvファイル PARODY_LYRIC_HEIGHT = Inches(5.5) PARODY_LYRIC_FONTSIZE = Pt(36) ORIGINAL_LYRIC_HEIGHT = Inches(6.5) ORIGINAL_LYRIC_FONTSIZE = Pt(28) IMG_DISPLAY_HEIGHT = Inches(3) #スライドに表示するときの画像の高さ。とりあえず3インチとしておく。 IMG_CENTER_X, IMG_CENTER_Y = SLIDE_WIDTH/2, SLIDE_HEIGHT/2 #画像の中心座標```設定ファイルの情報を取得

対応表の情報をname2path(dict型)、歌詞定義ファイルの情報をlyrics(list型)という変数に代入します。

name2path = {} with open(IMG_FILE_PATH,"r") as f: text = [v.split(',') for v in f.read().split("\n")] for v in text: if len(v) == 2: name2path[v[0]]=IMG_DIR+v[1] lyrics=[] with open(LYRIC_FILE_PATH,"r") as f: lyrics = [v.split(',') for v in f.read().split("\n") if len(v.split(','))==3]プレゼンテーションオブジェクトの生成とサイズ指定

スライドサイズはPresentation.slide_width、Presentation.slide_heightに値を代入することで変更できます。

#スライドオブジェクトの定義 prs = Presentation() #スライドサイズの指定 prs.slide_width = SLIDE_WIDTH prs.slide_height = SLIDE_HEIGHTfor文でlyricsの各要素に対応するスライドを追加する

ここからfor文でlyricsの各要素に対応するスライドを追加していく処理について説明します。まずlyricの0、1、2番めの要素がそれぞれ本来の歌詞(original_text)、替え歌歌詞(parody_text)、画像ID(img_id)に対応しているので、取得します。

画像IDが対応表に存在しない場合は、continueします。存在する場合は、ファイルパス(img_file)を取得します。for index,lyric in enumerate(lyrics): original_text = lyric[0] parody_text = lyric[1] img_id = lyric[2] if img_id not in name2path: print("img_id",img_id,"does not exist") print("line",index,":",lyric,"is ignored") continue img_file = name2path[img_id]白紙スライドを追加する

白紙のスライドをPresentationオブジェクトにadd_slideします。

#白紙スライドの追加 blank_slide_layout = prs.slide_layouts[6] slide = prs.slides.add_slide(blank_slide_layout)スライドの背景を黒くする

#背景を黒くする shapes = slide.shapes left, top, width, height = 0, 0, SLIDE_WIDTH, SLIDE_HEIGHT shape = shapes.add_textbox(left,top,width,height) fill = shape.fill fill.solid() fill.fore_color.rgb = BACKGROUD_RGBスライドと同じサイズのtextBoxを追加し、黒く塗りつぶします。

画像の挿入

画像をIMG_CENTER_X, IMG_CENTER_Yを中心とする位置に挿入します。

本来、python-pptxによるadd_pictureでは左上の座標位置しか指定できませんが、「〇〇で歌ってみた」動画では絵が切り替わる前後で画像中心が揃ってたほうが見栄えがいいので、画像サイズを別途取得した上で、センタリングで挿入します。

詳しいやり方はpython-pptxで画像をセンタリングするにまとめたので参考にしてください。#画像サイズを取得してアスペクト比を得る im = Image.open(img_file) im_width, im_height = im.size aspect_ratio = im_width/im_height #表示された画像のサイズを計算 img_display_height = IMG_DISPLAY_HEIGHT img_display_width = aspect_ratio*img_display_height #センタリングする場合の画像の左上座標を計算 left = IMG_CENTER_X - img_display_width / 2 top = IMG_CENTER_Y - img_display_height / 2 #画像をスライドに追加 slide.shapes.add_picture(img_file, left, top, height = IMG_DISPLAY_HEIGHT)替え歌歌詞の挿入

替え歌歌詞を追加します。

テキストボックスの幅をスライド幅と同じに指定した上で、PP_ALIGN.CENTERで左右方向のセンタリングをすることで、歌詞が真ん中に表示されるようにします。

文字色、文字サイズはそれぞれfont.size、font.color.rgbに値を代入して指定します。#テキストボックスを追加 left, top, width, height = 0, PARODY_LYRIC_HEIGHT, SLIDE_WIDTH, Inches(1) txBox = slide.shapes.add_textbox(left, top, width, height) tf = txBox.text_frame tf.text = parody_text paragraph = tf.paragraphs[0] font = paragraph.font font.size = PARODY_LYRIC_FONTSIZE font.color.rgb = FONT_RGB paragraph.alignment = PP_ALIGN.CENTER #左右方向のセンタリング本来の歌詞の挿入

本来の歌詞を挿入します。やり方は替え歌歌詞の挿入と同じです。

#テキストボックスを追加 left, top, width, height = 0, ORIGINAL_LYRIC_HEIGHT, SLIDE_WIDTH, Inches(1) txBox = slide.shapes.add_textbox(left, top, width, height) tf = txBox.text_frame tf.text = original_text paragraph = tf.paragraphs[0] font = paragraph.font font.size = ORIGINAL_LYRIC_FONTSIZE font.color.rgb = FONT_RGB paragraph.alignment = PP_ALIGN.CENTER出力

for文を終えたら、Presentation.saveでpptxファイルを出力します。

prs.save(OUTPUT_FILE_PATH)コード全体

コード全体は下記です。

generate_pptx.pyfrom pptx import Presentation from pptx.util import Inches, Pt from pptx.enum.text import PP_ALIGN from PIL import Image from pptx.dml.color import RGBColor #スライドサイズ #4:3 (default) 9144000x6858000 #16:9 12193200x6858000 SLIDE_WIDTH = 12193200 SLIDE_HEIGHT = 6858000 BACKGROUD_RGB = RGBColor(0,0,0) FONT_RGB = RGBColor(255,255,255) OUTPUT_FILE_PATH = "test.pptx" #替え歌歌詞テキストボックスの左上座標の高さ (左右方向は中央揃えするので不要) IMG_FILE_PATH = "img_file_names.csv"#1行につきidと画像パスがひとつずつ書かれたcsvファイル IMG_DIR = "./picture/" LYRIC_FILE_PATH = "lyric.csv"#1行につき本来の歌詞、替え歌歌詞、画像ファイルIDが一つずつ書かれたcsvファイル PARODY_LYRIC_HEIGHT = Inches(5.5) PARODY_LYRIC_FONTSIZE = Pt(36) ORIGINAL_LYRIC_HEIGHT = Inches(6.5) ORIGINAL_LYRIC_FONTSIZE = Pt(28) IMG_DISPLAY_HEIGHT = Inches(3) #スライドに表示するときの画像の高さ。とりあえず3インチとしておく。 IMG_CENTER_X, IMG_CENTER_Y = SLIDE_WIDTH/2, SLIDE_HEIGHT/2 #画像の中心座標 name2path = {} with open(IMG_FILE_PATH,"r") as f: text = [v.split(',') for v in f.read().split("\n")] for v in text: if len(v) == 2: name2path[v[0]]=IMG_DIR+v[1] lyrics=[] with open(LYRIC_FILE_PATH,"r") as f: lyrics = [v.split(',') for v in f.read().split("\n") if len(v.split(','))==3] #スライドオブジェクトの定義 prs = Presentation() #スライドサイズの指定 prs.slide_width = SLIDE_WIDTH prs.slide_height = SLIDE_HEIGHT for index,lyric in enumerate(lyrics): original_text = lyric[0] parody_text = lyric[1] img_id = lyric[2] if img_id not in name2path: print("img_id",img_id,"does not exist") print("line",index,":",lyric,"is ignored") continue img_file = name2path[img_id] #白紙スライドの追加 blank_slide_layout = prs.slide_layouts[6] slide = prs.slides.add_slide(blank_slide_layout) #背景を黒くする shapes = slide.shapes left, top, width, height = 0, 0, SLIDE_WIDTH, SLIDE_HEIGHT shape = shapes.add_textbox(left,top,width,height) fill = shape.fill fill.solid() fill.fore_color.rgb = BACKGROUD_RGB #画像サイズを取得してアスペクト比を得る im = Image.open(img_file) im_width, im_height = im.size aspect_ratio = im_width/im_height #表示された画像のサイズを計算 img_display_height = IMG_DISPLAY_HEIGHT img_display_width = aspect_ratio*img_display_height #センタリングする場合の画像の左上座標を計算 left = IMG_CENTER_X - img_display_width / 2 top = IMG_CENTER_Y - img_display_height / 2 #画像をスライドに追加 slide.shapes.add_picture(img_file, left, top, height = IMG_DISPLAY_HEIGHT) #テキストボックスを追加 left, top, width, height = 0, PARODY_LYRIC_HEIGHT, SLIDE_WIDTH, Inches(1) txBox = slide.shapes.add_textbox(left, top, width, height) tf = txBox.text_frame tf.text = parody_text paragraph = tf.paragraphs[0] font = paragraph.font font.size = PARODY_LYRIC_FONTSIZE font.color.rgb = FONT_RGB paragraph.alignment = PP_ALIGN.CENTER #テキストボックスを追加 left, top, width, height = 0, ORIGINAL_LYRIC_HEIGHT, SLIDE_WIDTH, Inches(1) txBox = slide.shapes.add_textbox(left, top, width, height) tf = txBox.text_frame tf.text = original_text paragraph = tf.paragraphs[0] font = paragraph.font font.size = ORIGINAL_LYRIC_FONTSIZE font.color.rgb = FONT_RGB paragraph.alignment = PP_ALIGN.CENTER prs.save(OUTPUT_FILE_PATH)おわりに

pptxファイルが出力されたら、微調整をして、書き出し機能でpngなどに書き出すことで、動画編集ソフトの素材として使えると思います。

上記のコードでできあがるのはシンプルなスライドですが、歌詞や画像の挿入位置、文字色や背景色を変えるなどして、好みのデザインにしてみてください。

- 投稿日:2020-03-22T22:36:16+09:00

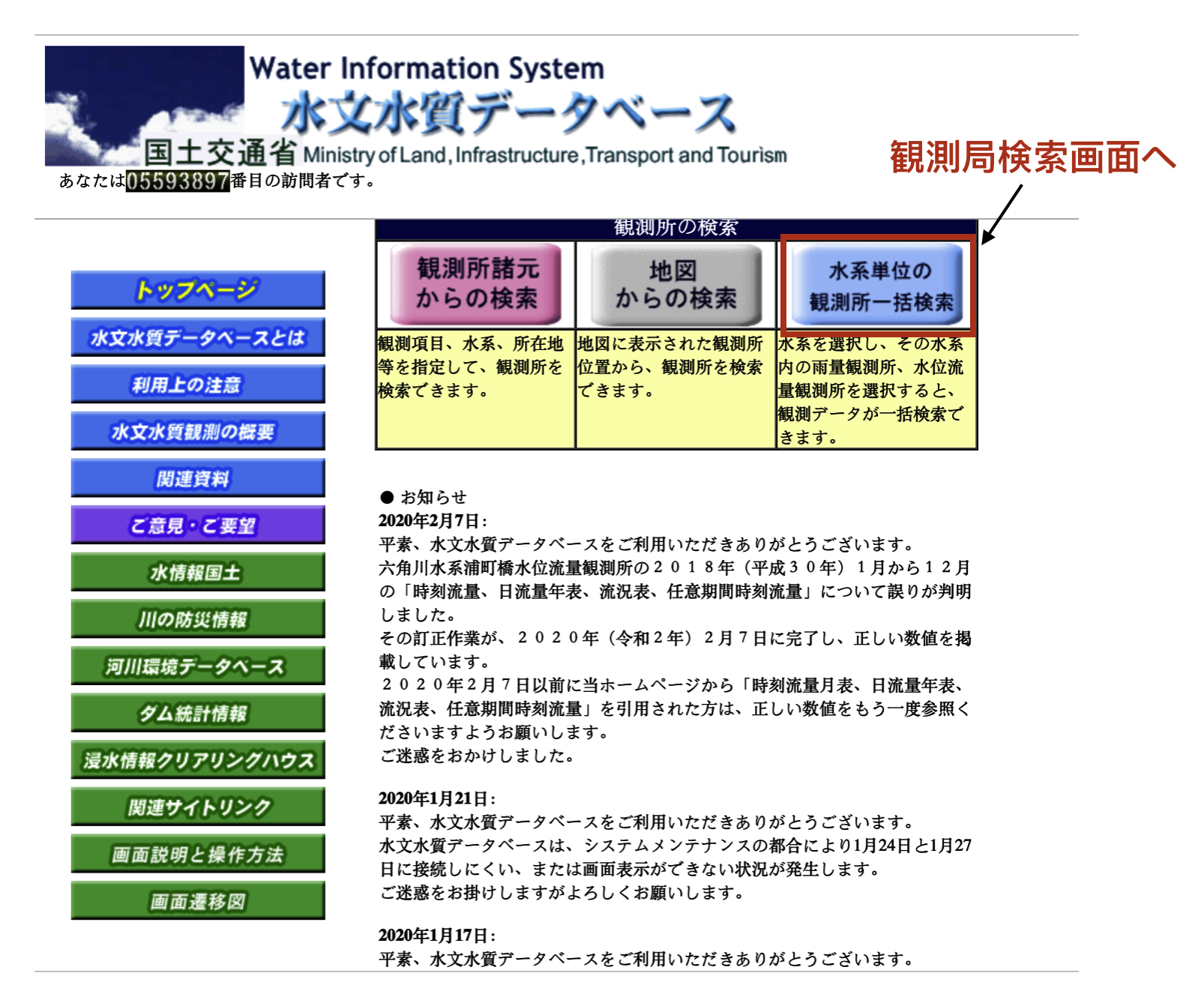

Docker Compose でWebアプリケーションを開発する環境(NGINX + uWSGI + PostgreSQL)を構築する。

はじめに

Docker Composeを使って、NGINX、uWSGI、PostgreSQLが動作するDocker コンテナを構築し、

Django(Python)で開発したWebアプリケーションをブラウザで動作確認するまでの手順を記載します。

※ 本投稿は、Mac OSを前提としています。

macOS Catalina 10.15.3で作業しています。

No. 項目 説明 1 Docker Compose 複数のDocker コンテナを一元管理するツールです。

本投稿では、NGINX、uWSGI、PostgreSQLが動作するDocker コンテナを

構築します。2 NGINX Webサーバです。

本投稿では、ここに静的ファイルを配置します。3 uWSGI アプリケーションサーバです。

Pythonで作成したWebアプリケーションを配置します。4 PostgreSQL DBサーバです。

Webアプリケーションで利用するデータを保持します。5 Django PythonのWebフレームワークです。 前提条件

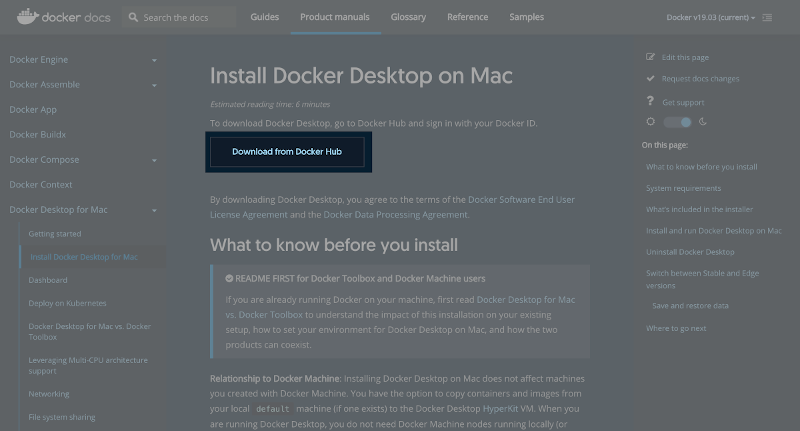

Docker for Macをダウンロードする際、Dockerの公式サイトにログインする必要があります。

Dockerの公式サイトにログインするためのユーザを作成して下さい。1. Docker for Mac

最初にDocker for Macのインストールを行います。

Docker Composeは、Docker for Macに含まれています。1-1. ダウンロード

以下のサイトからダウンロードします。

https://docs.docker.com/docker-for-mac/install/(1) 「Download from Docker Hub」ボタンを押下します。

(2) 「Download Docker Desktop for Mac」ボタンを押下します。

Docker.dmg がダウンロードされます。

1-2. インストール

(1) Docker.dmgの実行

ダウンロードした Docker.dmg を実行して下さい。(2) Applicationsに移動

DockerをApplicationsに移動させます。

(3) Dockerの実行

アプリケーションからDockerを実行して下さい。1-3. 確認

(1) ターミナルを開き、"docker --version"を実行します。

インストールしたDockerのバージョンを確認します。$ docker --version Docker version 19.03.5, build 633a0ea(2) 次に、"docker-compose --version"を実行します。

Docker Composeのバージョンを確認します。$ docker-compose --version docker-compose version 1.25.4, build 8d51620a2. Docker コンテナの構築

NGINX、uWSGI、PostgreSQLが動作するDocker コンテナを構築します。

2-1. 作業ディレクトリの作成

任意の作業ディレクトリを作成して下さい。

本投稿では、"django"を作成します。$ mkdir django2-2. ファイル/ディレクトリの準備

Docker Composeの実行に必要なファイル、Webアプリケーションのソースコードを

配置するディレクトリなどを準備します。(1) 作業ディレクトリへの移動

$ cd django(2) requirements.txt の作成

$ touch requirements.txt(3) Dockerfile の作成

$ touch Dockerfile(4) docker-compose.yml の作成

$ touch docker-compose.yml(5) nginx ディレクトリの作成

$ mkdir nginx(6) nginx/conf ディレクトリの作成

$ mkdir nginx/conf(7) nginx/conf/mainproject_nginx.conf の作成

$ touch nginx/conf/mainproject_nginx.conf(8) nginx/uwsgi_params の作成

$ touch nginx/uwsgi_params(9) src ディレクトリの作成

$ mkdir src(10) src/static ディレクトリの作成

$ mkdir src/static(11) dbdata ディレクトリの作成

$ mkdir dbdata[ファイル/ディレクトリの説明]

No. 名称 説明 1 requirements.txt 利用するPythonのパッケージ(ライブラリ)を指定するファイル 2 Dockerfile Docker コンテナの構成情報を記述するためのファイル 3 docker-compose.yml アプリケーションを動かすための処理を記述するファイル 4 nginx NGINXのルートディレクトリ 5 nginx/conf NGINXの設定ファイルを配置するディレクトリ 6 nginx/conf/mainproject_nginx.conf NGINXの設定を記述するためのファイル

※ ファイル名は任意です、拡張子は".conf"にして下さい。7 nginx/uwsgi_params NGINXとuWSGIを連携させるためのファイル 8 src Webアプリケーションを配置するディレクトリ 9 src/static css、JavaScript、画像などの静的ファイルを配置するディレクトリ 10 dbdata PostgreSQLのデータファイルを保持するディレクトリ [ここまでのファイル構成]

$ tree . . ├── Dockerfile ├── dbdata ├── docker-compose.yml ├── nginx │ ├── conf │ │ └── mainproject_nginx.conf │ └── uwsgi_params ├── requirements.txt └── src └── static 5 directories, 5 files2-3. requirements.txtの設定

requirements.txtを開き、以下の内容を記述して保存します。

requirements.txtは、次に説明するDockerfileの中で利用しています。

("RUN pip install -r requirements.txt"の箇所)Django django-bootstrap4 uwsgi psycopg2[説明]

① Django

PythonのWebフレームワークのDjangoをインストールします。

② django-bootstrap4

DjangoでBootstrap4を利用するためのパッケージをインストールします。

※ Bootstrap4を利用しない場合、インストールする必要はありません。

最後にDjangoで作成したページにBootstrap4を適用する方法を参考に紹介します。

③ uwsgi

アプリケーションサーバをインストールします。

④ psycopg2

PythonからPostgreSQLに接続するためのドライバをインストールします。2-4. Dockerfileの設定

Dockerfileを開き、以下の内容を記述して保存します。

Dockerfileは、次に説明するdocker-compose.ymlの中で利用しています。

("build: ."の箇所)FROM python:3.7 ENV PYTHONUNBUFFERED 1 RUN mkdir /code WORKDIR /code COPY requirements.txt /code/ RUN pip install --upgrade pip RUN pip install -r requirements.txt COPY . /code/[説明]

① FROM python:3.7

Docker のベースイメージに"python3.7"を指定

"Docker Hub"のイメージから作成します。

② ENV PYTHONUNBUFFERED 1

Python の標準出力、標準エラー出力をバッファに溜め込まない設定となります。

バッファが有効になっていると、標準出力の途中経過が表示されず、

全てのタスクが終わった後に纒めて表示されます。

③ RUN mkdir /code

コンテナ上にcodeディレクトリを作成します。

④ WORKDIR /code

コンテナの作業ディレクトリにcodeディレクトリを指定します。

⑤ COPY requirements.txt /code/

ローカルマシンのrequirements.txtをコンテナのcodeディレクトリに追加します。

⑥ RUN pip install --upgrade pip

コンテナ上のpipを最新のバージョンにします。

⑦ RUN pip install -r requirements.txt

requirements.txtに記載しているPythonのパッケージ(ライブラリ)を

コンテナ上インストールします。

⑧ ローカルマシンのカレントディレクトリの内容をコンテナのcodeディレクトリに追加します。

2-5. docker-compose.ymlの設定

docker-compose.ymlを開き、以下の内容を記述して保存します。

version: '3.7' volumes: pgdata: driver_opts: type: none device: $PWD/dbdata o: bind services: nginx: image: nginx container_name: container.nginx ports: - "8000:8000" volumes: - ./nginx/conf:/etc/nginx/conf.d - ./nginx/uwsgi_params:/etc/nginx/uwsgi_params - ./src/static:/static - ./nginx/log:/var/log/nginx depends_on: - web web: build: . container_name: container.uwsgi command: uwsgi --ini /code/mainproject/django.ini volumes: - ./src:/code expose: - "8001" depends_on: - db db: image: postgres restart: always container_name: container.postgres ports: - "5432:5432" environment: POSTGRES_DB: "postgresdb" POSTGRES_USER: "admin" POSTGRES_PASSWORD: "test" POSTGRES_INITDB_ARGS: "--encoding=UTF-8 --locale=C" volumes: - pgdata:/var/lib/postgresql/data hostname: postgres[説明]

① version: '3.7'

docker-composeで使用するバージョンとなります。

バージョンによって、docker-compose.ymlの書き方が異なります。

※ Docker 本体のバージョンとの関連は「Compose file version 3 reference」を参照して下さい。

② volumes:

トップレベルのvolumesは、名前付きvolumeとなります。

ここでは、"pgdata"という名前付きvolumeを指定しています。

"device: $PWD/dbdata"は、ローカルマシンの作業ディレクトリ配下のdbdataディレクトリを表します。

③ services:

構築するコンテナを記述します。

ここでは、"nginx"、"web"、"db"を記述しています。

この名前は任意で指定が可能です。

例えば、"db"は、"database"などでも問題ありません。

③-1 nginx:

③-1-1 image: nginx

NGINXが動作するコンテナは、"Docker Hub"のイメージから作成します。

③-1-2 container_name: container.nginx

"container.nginx"という任意のコンテナ名を付けます。

③-1-3 ports:

NGINXのポート番号に8000ポートを指定します。

③-1-4 volumes:

ローカルマシンの作業ディレクトリ配下の各ファイル/ディレクトリと

NGINXのコンテナのファイル/ディレクトリのマウントを設定します。

a) ./nginx/conf:/etc/nginx/conf.d

これにより、"nginx/conf/mainproject_nginx.conf"が"/etc/nginx/conf.d"にマウントされます。

"/etc/nginx/conf.d"に配置した拡張子".conf"のファイルは、

親の設定ファイルにあたる"/etc/nginx/nginx.conf"によって読み込まれます。

* "/etc/nginx/nginx.conf"は、nginxのコンテナにデフォルトで存在します。

b) ./nginx/uwsgi_params:/etc/nginx/uwsgi_params

"/etc/nginx/uwsgi_params"は、次に説明する"nginx/conf/mainproject_nginx.conf"の中で利用しています。

("include /etc/nginx/uwsgi_params;"の箇所)

c) ./src/static:/static

静的ファイルを配置するディレクトリをマウントします。

cssなどをNGINXから配信するための設定となります。

d) ./nginx/log:/var/log/nginx

ログファイルを配置するディレクトリをマウントします。

これにより、ローカル上でログを確認できるようになります。

③-1-5 depends_on:

"web"、つまりuWSGIのコンテナが起動された後に、NGINXのコンテナを起動するという指定です。

③-2 web:

③-2-1 build: .

uWSGIが動作するコンテナは、Dockerfileに記述したコンテナの構成情報で作成します。

"build: ."は、ビルドに使用するDockerfileのパスを表します。

つまり、このコンテナは、Dockerfileに記載したコンテナの構成情報で作成します。

③-2-2 container_name: container.uwsgi

"container.uwsgi"という任意のコンテナ名を付けます。

③-2-3 command: uwsgi --ini /code/mainproject/django.ini

コンテナが起動した後に、uWSGIを設定ファイル"/code/mainproject/django.ini"の

内容に従って、起動させるということを表します。

③-2-4 volumes:

ローカルマシンの作業ディレクトリ配下の各ディレクトリと

uWSGIのコンテナのディレクトリのマウントを設定します。

③-2-5 expose:

uWSGIのポート番号に8001ポートを指定します。

③-2-6 depends_on:

"db"、つまりPostgreSQLのコンテナが起動された後に、uWSGIのコンテナを起動するという指定です。

③-3 db:

③-3-1 image: postgres

PostgreSQLが動作するコンテナは、"Docker Hub"のイメージから作成します。

③-3-2 restart: always

ホストOSを起動したタイミングでコンテナを自動起動するという指定です。

③-3-3 container_name: container.postgres

"container.postgres"という任意のコンテナ名を付けます。

③-3-4 ports:

PostgreSQLのポート番号に5432ポートを指定します。

③-3-5 environment:

a) POSTGRES_DB: "postgresdb"

コンテナ起動時に作成するデフォルトのDBの名称を指定します。

指定しない場合、POSTGRES_USERの値が使われます。

b) POSTGRES_USER: "admin"

スーパユーザの名称を指定します。

指定しない場合、"postgres"が使われます。

c) POSTGRES_PASSWORD: "test"

スーパユーザのパスワードを指定します。

指定しない場合、POSTGRES_USERの値が使われます。

d) POSTGRES_INITDB_ARGS: "--encoding=UTF-8 --locale=C"

DBを作成するコマンド(postgres initdb)を実行する際に渡す引数を指定します。

エンコーディングに"UTF-8"、ロケールに"C"を指定しています。

※ environmentの詳細は、「Supported tags and respective Dockerfile links 」を参照して下さい。

③-3-6 volumes:

名前付きvolumeの"pgdata"と

PostgreSQLコンテナの"/var/lib/postgresql/data"のマウントを設定します。

この設定により、DBのデータが永続化されます。

(コンテナを削除してもデータがローカルマシン上に残ります。)

③-3-7 hostname:

"postgres"という任意のホスト名を付けます。2-6. nginx/conf/mainproject_nginx.confの設定

nginx/conf/mainproject_nginx.confを開き、以下の内容を記述して保存します。

# the upstream component nginx needs to connect to upstream django { ip_hash; server web:8001; } # configuration of the server server { # the port your site will be served on listen 8000; # the domain name it will serve for server_name 127.0.0.1; # substitute your machine's IP address or FQDN charset utf-8; # max upload size client_max_body_size 75M; # adjust to taste location /static { alias /static; } # Finally, send all non-media requests to the Django server. location / { uwsgi_pass django; include /etc/nginx/uwsgi_params; # the uwsgi_params file you installed } }[説明]

① upstream django

細かい設定方法は割愛しますが、"server web:8001;"については、

docker-compose.ymlに記載したweb(ポート番号は、8001)を指しています。

つまり、uWSGIを指しています。

② server

こちらも細かい設定方法は割愛しますが、"location / {"については、

NGINXのルートにアクセスがあった場合、①で説明したuWSGIに処理を渡すという設定になります。

また、③-1-4で説明した/etc/nginx/uwsgi_paramsの設定ファイルに基づいて連携しています。

"location /static {"については、

静的ファイルについては、NGINXのstaticディレクトリに配置したものを使用するという設定です。2-7. nginx/uwsgi_paramsの設定

nginx/uwsgi_paramsを開き、以下の内容を記述して保存します。

uwsgi_param QUERY_STRING $query_string; uwsgi_param REQUEST_METHOD $request_method; uwsgi_param CONTENT_TYPE $content_type; uwsgi_param CONTENT_LENGTH $content_length; uwsgi_param REQUEST_URI $request_uri; uwsgi_param PATH_INFO $document_uri; uwsgi_param DOCUMENT_ROOT $document_root; uwsgi_param SERVER_PROTOCOL $server_protocol; uwsgi_param REQUEST_SCHEME $scheme; uwsgi_param HTTPS $https if_not_empty; uwsgi_param REMOTE_ADDR $remote_addr; uwsgi_param REMOTE_PORT $remote_port; uwsgi_param SERVER_PORT $server_port; uwsgi_param SERVER_NAME $server_name;2-9. Djangoプロジェクトの作成

以下のコマンドを実行し、Djangoプロジェクトを作成します。

プロジェクト名は任意です。(ここでは、"mainproject"という名前にしました。)$ docker-compose run --rm web django-admin.py startproject mainproject .下記のようなWARNINGが出力されますが、「イメージが存在していなかったので、ビルドした」という

警告なので、問題ありません。WARNING: Image for service web was built because it did not already exist. To rebuild this image you must use `docker-compose build` or `docker-compose up --build`.[実行結果の確認①(ファイル構成)]

ファイル構成は以下の構成となります。

※ dbdata配下には、マウントしたPostgreSQLのデータ(/var/lib/postgresql/data)が

大量に作成されるので、省略しています。$ tree . . ├── Dockerfile ├── dbdata │ ├── PG_VERSION │ ├── base │ │ └── ・・・ 省略 │ │ └── ・・・ 省略 │ └── ・・・ 省略 ├── docker-compose.yml ├── nginx │ ├── conf │ │ └── mainproject_nginx.conf │ └── uwsgi_params ├── requirements.txt └── src ├── mainproject │ ├── __init__.py │ ├── asgi.py │ ├── settings.py │ ├── urls.py │ └── wsgi.py ├── manage.py └── static[実行結果の確認②(Docker コンテナの状態)]

"docker ps -a"コマンドを実行し、Docker コンテナの状態を確認して下さい。

以下のようにPostgreSQLのコンテナが起動しています。

※ uWSGIのDocker コンテナについては、次に説明するuWSGIのiniファイルを作成していない為、

起動していません。(docker-compose.ymlの"command: uwsgi --ini /code/mainproject/django.ini"の箇所)

※ NGINXのDocker コンテナについては、uWSGIのDocker コンテナの起動が

前提条件となっていますので、こちらもまだ起動していません。$ docker ps -a CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 9d68d40adee0 postgres "docker-entrypoint.s…" 25 hours ago Up 25 hours 0.0.0.0:5432->5432/tcp container.postgres2-10. uWSGIのiniファイルを作成します。

src/mainproject/django.iniを新規に作成し、以下の内容を記述します。

[uwsgi] socket = :8001 module = mainproject.wsgi wsgi-file = /code/mainproject/wsgi.py logto = /code/mainproject/uwsgi.log py-autoreload = 1[説明]

① socket = :8001

uWSGIを起動するポート番号を指定します。

② module = mainproject.wsgi

loadするwsgiモジュールを指定します。

③ wsgi-file = /code/mainproject/wsgi.py

loadするwsgiファイルを指定します。

④ logto = /code/mainproject/uwsgi.log

ログを出力する場所を指定します。

アプリケーションのエラーが発生した時などに確認するログとなります。

⑤ py-autoreload = 1

オートリロード機能の間隔を指定します。

この設定では、1秒ごとにリクエストがあればリロードするという設定になります。

※ 詳細は、「uWSGI Options 」を参照して下さい。2-11. ALLOWED_HOST、DB及び静的ファイルの設定を行う。

src/mainproject/settings.pyを開き、以下の修正を行い保存します。

(1) ALLOWED_HOSTの設定

下記の修正を行います。

公開するドメイン名を設定します。

※ Django 1.5以降のsettings.pyに、ALLOWED_HOSTSという項目が追加されました。

これを設定しない場合、デバックモードがtrueの時にエラーとなります。(修正前)

ALLOWED_HOSTS = [](修正後)

ALLOWED_HOSTS = ["*"](2) DBへの接続設定

下記の修正を行います。

docker-compose.ymlのdbのenvironmentに合わせます。

(修正前)DATABASES = { 'default': { 'ENGINE': 'django.db.backends.sqlite3', 'NAME': os.path.join(BASE_DIR, 'db.sqlite3'), } }(修正後)

DATABASES = { 'default': { 'ENGINE': 'django.db.backends.postgresql', 'NAME': 'postgresdb', 'USER': 'admin', 'PASSWORD': 'test', 'HOST': 'db', 'PORT': 5432, } }(3) 静的ファイルの設定

下記の修正を行います。(修正前)

# Static files (CSS, JavaScript, Images) # https://docs.djangoproject.com/en/3.0/howto/static-files/ STATIC_URL = '/static/'(修正後)

# Static files (CSS, JavaScript, Images) # https://docs.djangoproject.com/en/3.0/howto/static-files/ # All applications can use Static files of this directory STATICFILES_DIRS = ( os.path.join(BASE_DIR, "mainproject/static/"), ) # Collectstatic command put STATICFILES_DIRS and each application's Static files together into this directory STATIC_ROOT = os.path.join(BASE_DIR, 'static/') # Django template files read this directory to use Static files(example {% static 'style.css' %}) STATIC_URL = '/static/'[説明]

① STATICFILES_DIRS

パスの指定先は任意です。

ここでは、「2-9. Djangoプロジェクトの作成」で説明した

Djangoプロジェクト(mainproject)配下のstaticディレクトリを指定しています。

このディレクトリには、各アプリケーションで共通の静的ファイルを配置します。

後術しますが、本投稿では、faviconを配置します。

② STATIC_ROOT

後術するCollectstaticコマンドを実行した際に、

STATICFILES_DIRSで指定した共通の静的ファイルと

各アプリケーション配下のstaticディレクトリの静的ファイルを

収集し、配置するディレクトリを指定します。

BASE_DIRは、作業ディレクトリ(src)のことなので、STATIC_ROOTは、src/staticとなります。

「2-5. docker-compose.ymlの設定」で説明したNGINXの静的ファイルのマウント元と一致します。

("- ./src/static:/static"の./src/staticの箇所)

③ STATIC_URL

後術するDjangoのテンプレートファイルが静的ファイルを読み込むディレクトリ先となります。

「2-5. docker-compose.ymlの設定」で説明したNGINXの静的ファイルのマウント先と一致します。

("- ./src/static:/static"の/staticの箇所)※ 「Django Static Files 」を合わせて見ると理解しやすいと思います。

2-12. Docker コンテナを起動します。

以下のコマンドを実行します。

$ docker-compose up -d[実行結果の確認①(Docker コンテナの状態)]

"docker ps -a"コマンドを実行し、Docker コンテナの状態を確認して下さい。

以下のようにNGINX、uWSGI、PostgreSQLのコンテナが起動しています。$ docker ps -a CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES f41f7a5b634d nginx "nginx -g 'daemon of…" 10 minutes ago Up 10 minutes 80/tcp, 0.0.0.0:8000->8000/tcp container.nginx c12eee7ac189 django_web "uwsgi --ini /code/m…" 10 minutes ago Up 10 minutes 8001/tcp container.uwsgi 9d68d40adee0 postgres "docker-entrypoint.s…" 27 hours ago Up 27 hours 0.0.0.0:5432->5432/tcp container.postgres2-13. 動作確認

ブラウザを開き、"http://0.0.0.0:8000"にアクセスし、

Djangoのデフォルトのページが表示されることを確認します。

ここまでの手順で、NGINX、uWSGI、PostgreSQLが動作するDocker コンテナの構築が完了しました。

3. Django Webアプリケーションの作成

Djangoで"Hello world."を出力するWebアプリケーションを作成します。

3-1. Djangoアプリケーションの作成

以下のコマンドを実行し、Djangoアプリケーションを作成します。

アプリケーション名は任意です。(ここでは、"app"という名前にしました。)$ docker-compose run --rm web python manage.py startapp app[実行結果の確認①(ファイル構成)]

srcディレクトリ配下にappディレクトリが作成されます。$ tree src src ├── app │ ├── __init__.py │ ├── admin.py │ ├── apps.py │ ├── migrations │ │ └── __init__.py │ ├── models.py │ ├── tests.py │ └── views.py ├── mainproject │ ├── __init__.py │ ├── __pycache__ │ │ ├── __init__.cpython-37.pyc │ │ ├── settings.cpython-37.pyc │ │ ├── urls.cpython-37.pyc │ │ └── wsgi.cpython-37.pyc │ ├── asgi.py │ ├── django.ini │ ├── settings.py │ ├── urls.py │ ├── uwsgi.log │ └── wsgi.py ├── manage.py └── static 5 directories, 19 files3-2. ビューの作成

"Hello world."を出力するファイルです。

src/app/views.pyを開き、以下の修正を行い保存します。(修正前)

from django.shortcuts import render # Create your views here.(修正後)

from django.http import HttpResponse def index(request): return HttpResponse("Hello world.")3-3. URLの対応付け

作成したビューをブラウザからアクセスするために、 URLの対応付けを行う必要があります。

(1) appディレクトリの配下にurls.pyを新規作成します。

urls.pyを作成することで、URLの対応付けに必要なURLconfが作成されます。

以下の内容を記述します。from django.urls import path from . import views urlpatterns = [ path('', views.index, name='index'), ](2) mainprojectディレクトリの配下のurls.pyを更新します。

ルート(プロジェクト)のURLconfにapp.urlsモジュールの記述を反映させます。

具体的には、

① django.urls.includeのimportを追加

② urlpatternsのリストにinclude('app.urls')を挿入

を行います。

※ 以下の修正前後のファイルは、文頭のコメント部分は省略しています。

※ include()関数は他のURLconfへの参照が可能になります。

修正後の"path('app/', include('app.urls'))"の箇所は、

app/にアクセスがあった場合、app配下のURLconfを参照するということを表します。(修正前)

from django.contrib import admin from django.urls import path urlpatterns = [ path('admin/', admin.site.urls), ](修正後)

from django.contrib import admin from django.urls import include, path urlpatterns = [ path('app/', include('app.urls')), path('admin/', admin.site.urls), ]3-4. 動作確認

ブラウザを開き、"http://0.0.0.0:8000/app/"にアクセスし、

画面に"Hello world."が表示されることを確認します。4. Databaseの設定

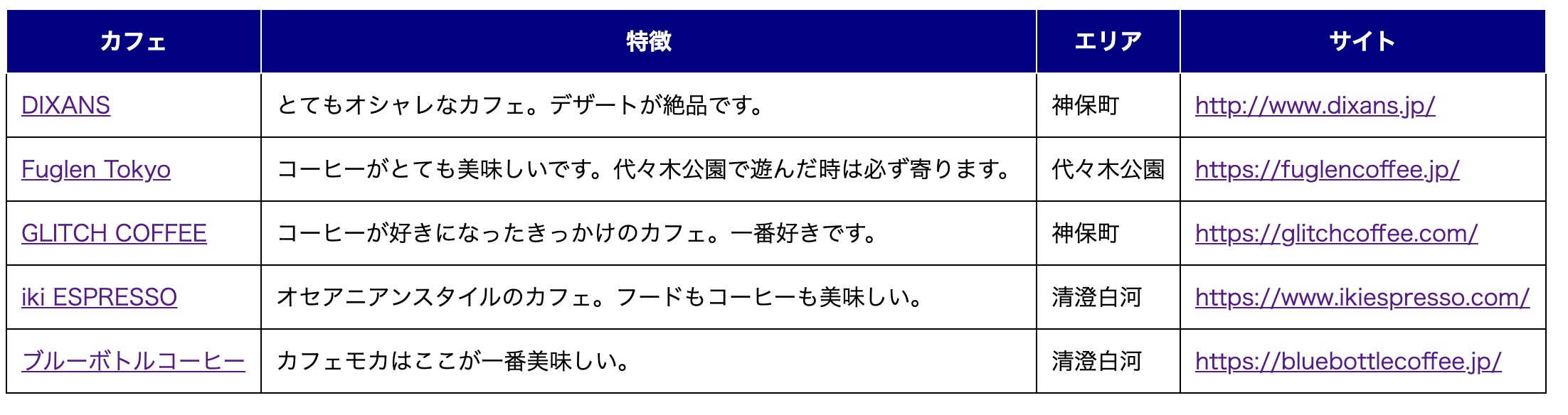

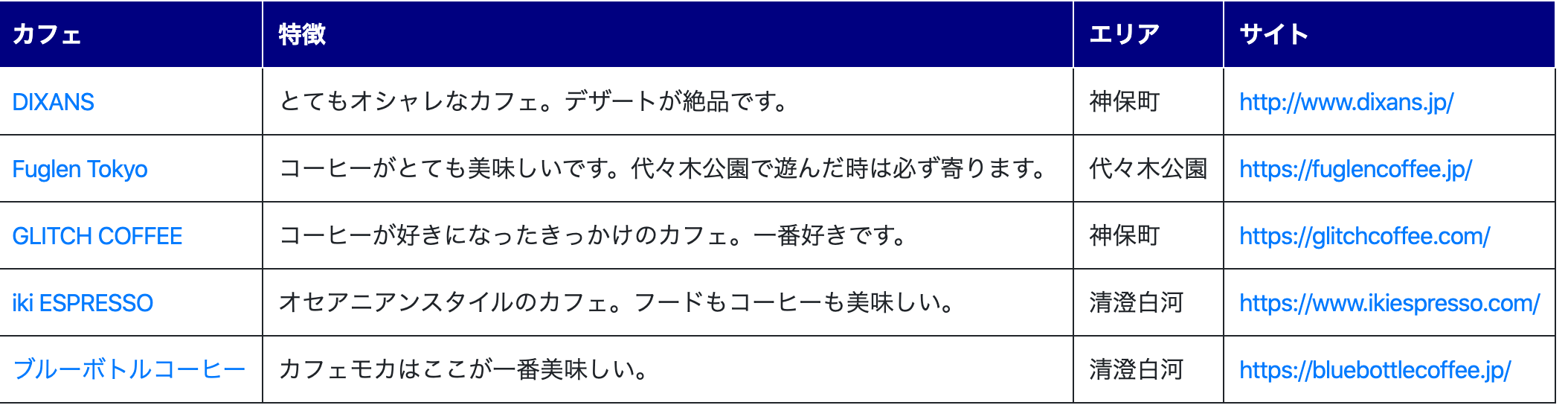

DjangoでDatabase(PostgreSQL)を利用するための設定を行います。

※ 私がCafe好きなので、Cafeの情報を例に説明します。4-1. モデルの作成

Webアプリケーションで利用するモデルを最初に定義します。

ここでは、Area、Cafe、Utilityの3つのモデルを作成します。

src/app/models.pyを開き、以下の内容を記述して保存します。(修正前)

from django.db import models # Create your models here.(修正後)

from django.db import models class Area(models.Model): name = models.CharField(max_length=100) create_date = models.DateTimeField('date published') def __str__(self): return self.name; class Cafe(models.Model): area = models.ForeignKey(Area, on_delete=models.CASCADE) name = models.CharField(max_length=100) memo = models.CharField(max_length=400) website = models.URLField() image_path = models.CharField(max_length=400) create_date = models.DateTimeField('date published') def __str__(self): return self.name; class Utility(models.Model): key = models.CharField(max_length=100) value = models.CharField(max_length=100) create_date = models.DateTimeField('date published') def __str__(self): return self.key;[説明]

① Area

Cafeのエリア情報(場所)を管理するマスタです。

② Cafe

Cafeの情報を保持するテーブルです。

※ ForeignKeyを使用してリレーションシップを定義しています。

各Cafeが1つのAreaに関連付けられています。

③ Utility

汎用的なデータを保持するマスタです。

今回は、表示方法の切り替えに利用します。

データの変更で、制御することで、毎回プログラムの変更を行う必要がなくなります。4-2. モデルを有効にする。

(1) モデル有効化の準備

src/mainproject/settings.pyを開き、INSTALLED_APPSに「'app.apps.AppConfig',」を追加します。

後術するmigrateコマンドを実行すると、INSTALLED_APPSに記述されている

アプリケーションに対し、各アプリケーションに必要なテーブルを作成します。

※ app.apps.AppConfigは、src/app/apps.pyのAppConfigクラスを表します。(修正前)

INSTALLED_APPS = [ 'django.contrib.admin', 'django.contrib.auth', 'django.contrib.contenttypes', 'django.contrib.sessions', 'django.contrib.messages', 'django.contrib.staticfiles', ](修正後)

INSTALLED_APPS = [ 'app.apps.AppConfig', 'django.contrib.admin', 'django.contrib.auth', 'django.contrib.contenttypes', 'django.contrib.sessions', 'django.contrib.messages', 'django.contrib.staticfiles', ](2) マイグレーションファイルの作成

以下のコマンドを実行し、モデルの変更内容が記述されたマイグレーションファイルを作成します。$ docker-compose run --rm web python manage.py makemigrations app下記のようなメッセージが出力され、src/app/migrations/0001_initial.pyが作成されます。

※ src/app/migrations/0001_initial.pyは、手動で調整することも可能です。$ docker-compose run --rm web python manage.py makemigrations app Starting container.postgres ... done Migrations for 'app': app/migrations/0001_initial.py - Create model Area - Create model Utility - Create model Cafe(3) テーブルの作成

マイグレーションファイルを元にモデルのテーブルを作成する。

以下のコマンドを実行します。$ docker-compose run --rm web python manage.py migrate下記のようなメッセージが出力され、テーブルが作成されます。

$ docker-compose run --rm web python manage.py migrate Starting container.postgres ... done Operations to perform: Apply all migrations: admin, app, auth, contenttypes, sessions Running migrations: Applying contenttypes.0001_initial... OK Applying auth.0001_initial... OK Applying admin.0001_initial... OK Applying admin.0002_logentry_remove_auto_add... OK Applying admin.0003_logentry_add_action_flag_choices... OK Applying app.0001_initial... OK Applying contenttypes.0002_remove_content_type_name... OK Applying auth.0002_alter_permission_name_max_length... OK Applying auth.0003_alter_user_email_max_length... OK Applying auth.0004_alter_user_username_opts... OK Applying auth.0005_alter_user_last_login_null... OK Applying auth.0006_require_contenttypes_0002... OK Applying auth.0007_alter_validators_add_error_messages... OK Applying auth.0008_alter_user_username_max_length... OK Applying auth.0009_alter_user_last_name_max_length... OK Applying auth.0010_alter_group_name_max_length... OK Applying auth.0011_update_proxy_permissions... OK Applying sessions.0001_initial... OK(4) テーブルの確認

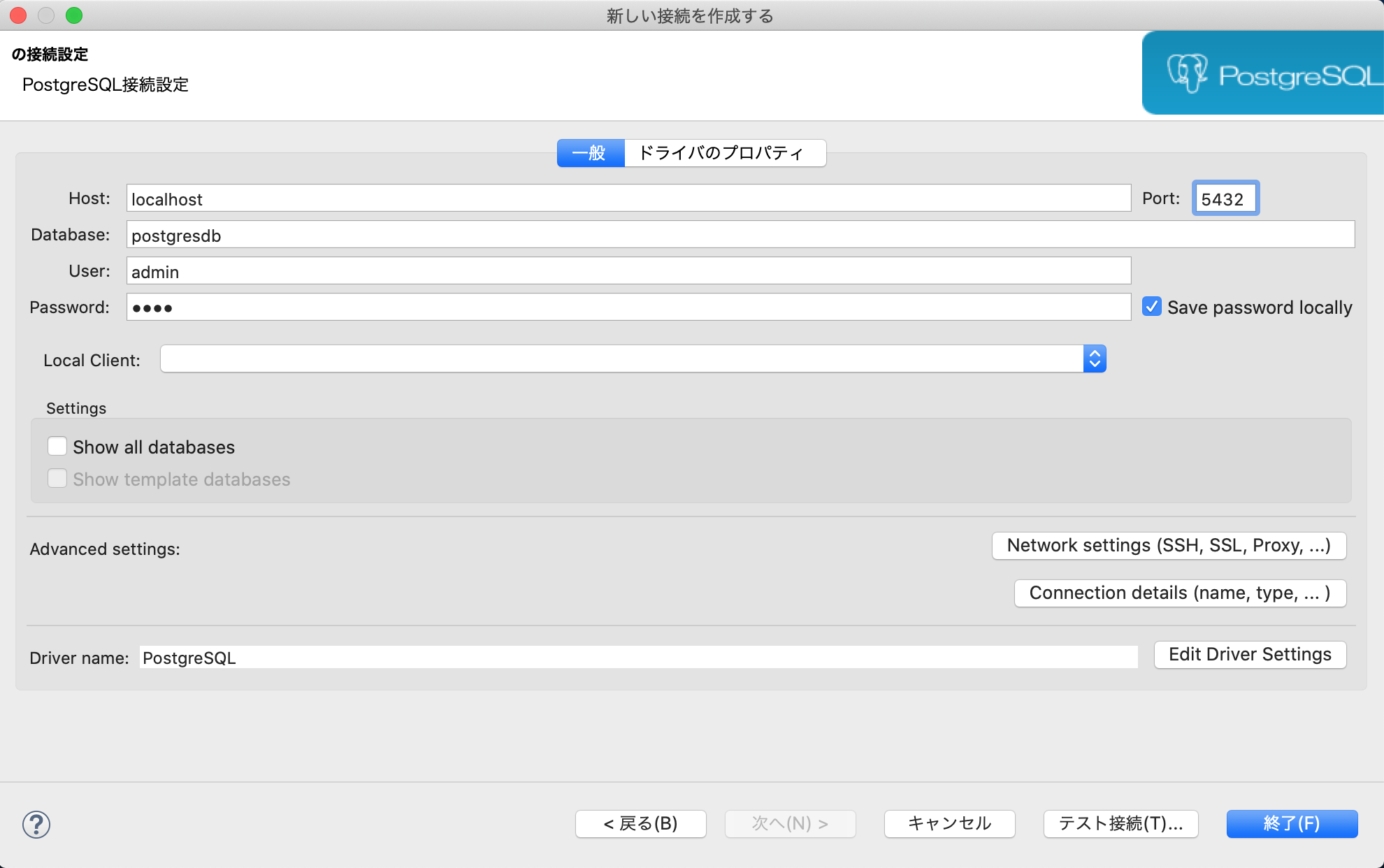

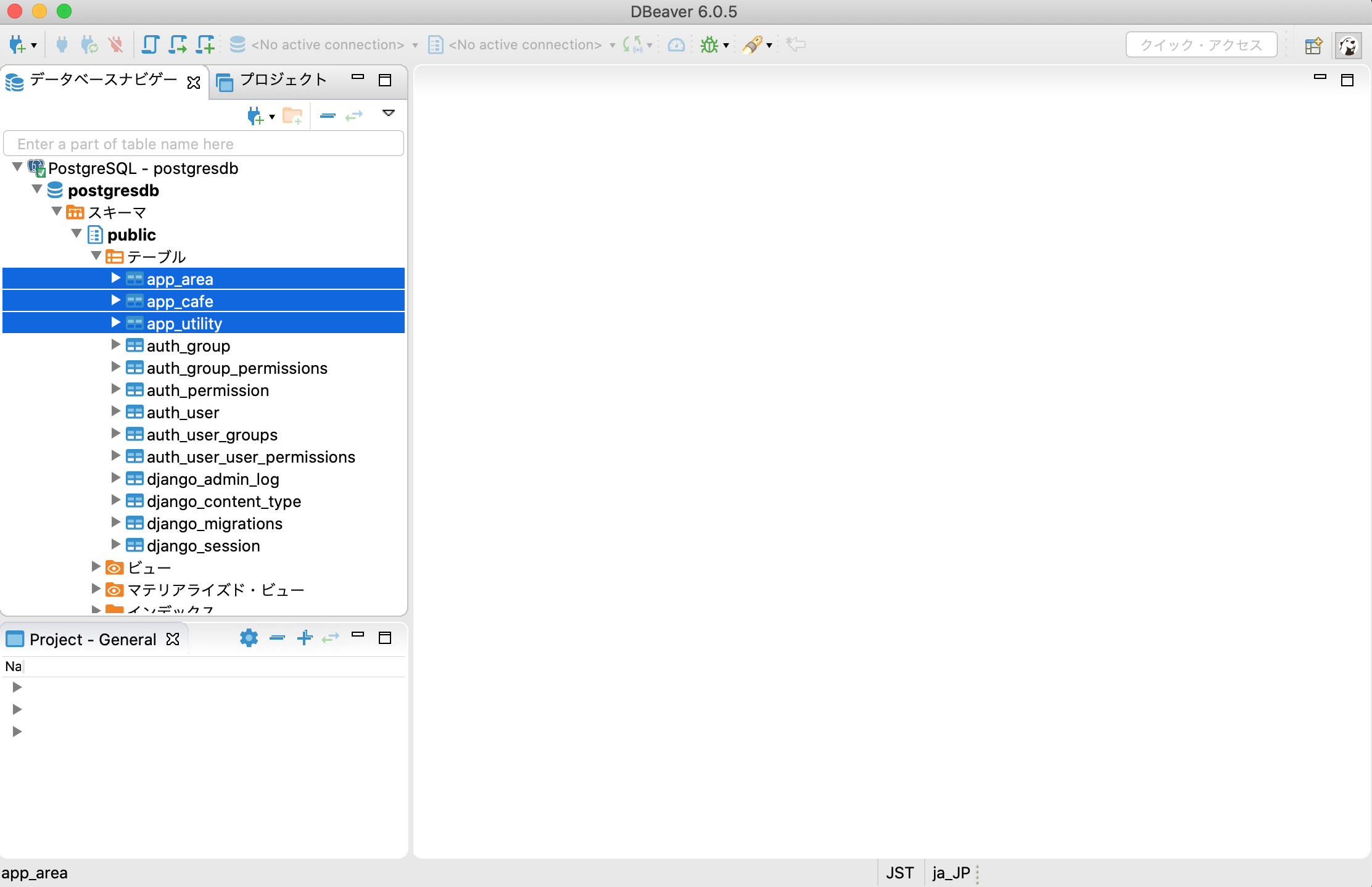

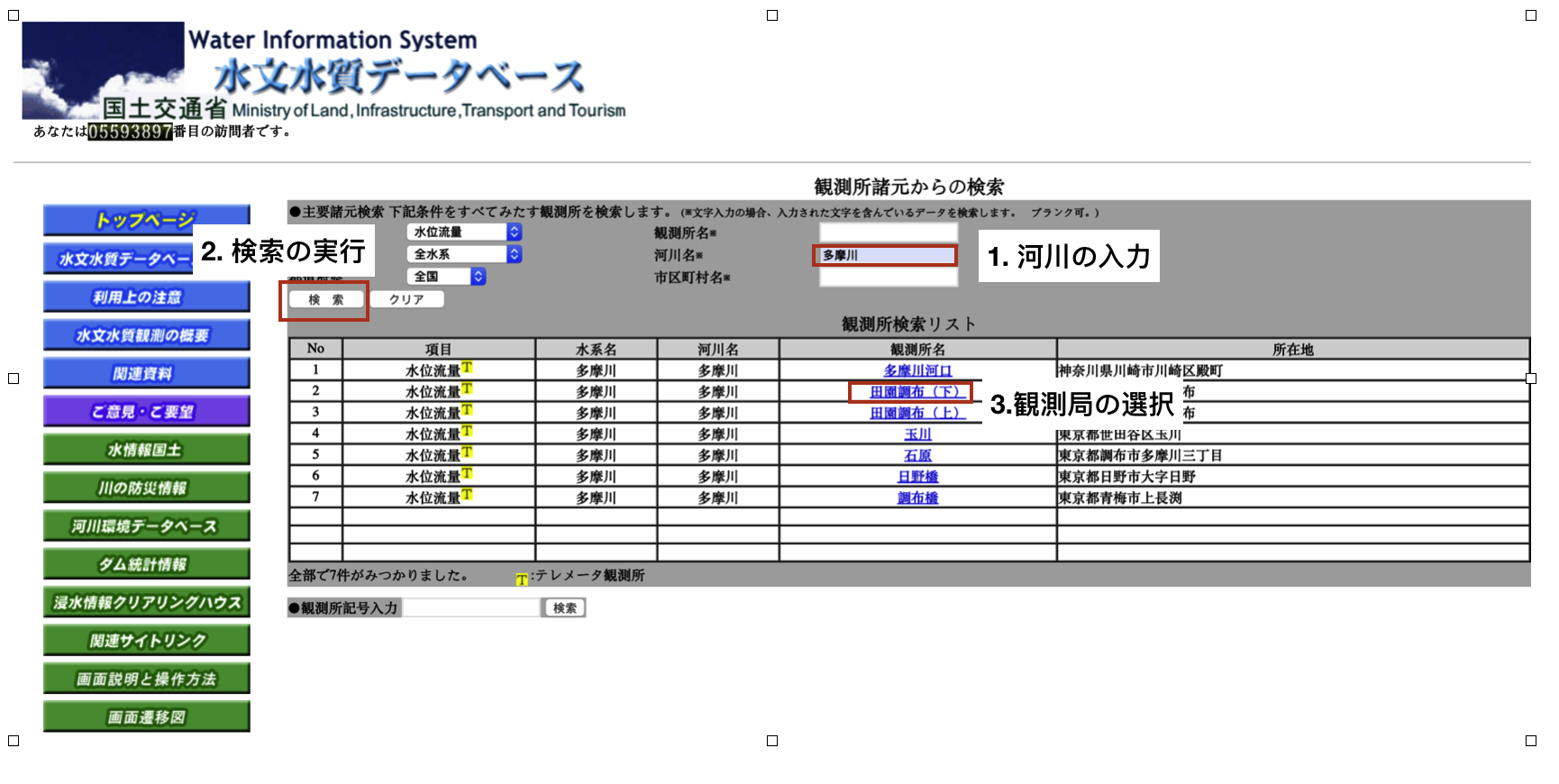

作成したテーブルをDBeaverというSQLクライアントツールを使って確認します。

DBeaverを使ったことがない方は、「DBeaverのインストールとPostgreSQLへの接続」を参考にして下さい。① DBeaverを起動します。

② 新しい接続を作成します。

以下の画面で、PostgreSQLに接続するDatabase、User、Password、Portの入力を行います。

※ 「2-11. ALLOWED_HOSTの設定、DBへの接続設定を行う。」の(2)で設定した内容を入力します。

③ テーブルの確認

下記の通り、app_area、app_cafe、app_utilityテーブルが作成されています。

(5) データの登録

下記のようなSQLを実行し、初期データを登録して下さい。insert into app_area (name, create_date) values ('清澄白河', now()); insert into app_area (name, create_date) values ('神保町', now()); insert into app_area (name, create_date) values ('代々木公園', now()); insert into app_cafe (name, memo, website, image_path, create_date, area_id) values ('ブルーボトルコーヒー', 'カフェモカはここが一番美味しい。', 'https://bluebottlecoffee.jp/', 'bluebottlecoffee_IMG.jpg', now(), '1'); insert into app_cafe (name, memo, website, image_path, create_date, area_id) values ('iki ESPRESSO', 'オセアニアンスタイルのカフェ。フードもコーヒーも美味しい。', 'https://www.ikiespresso.com/', 'ikiespresso_IMG.jpg', now(), '1'); insert into app_cafe (name, memo, website, image_path, create_date, area_id) values ('GLITCH COFFEE', 'コーヒーが好きになったきっかけのカフェ。一番好きです。', 'https://glitchcoffee.com/', 'glitchcoffee_IMG.jpg', now(), '2'); insert into app_cafe (name, memo, website, image_path, create_date, area_id) values ('DIXANS', 'とてもオシャレなカフェ。デザートが絶品です。', 'http://www.dixans.jp/', 'dixans_IMG.jpg', now(), '2'); insert into app_cafe (name, memo, website, image_path, create_date, area_id) values ('Fuglen Tokyo', 'コーヒーがとても美味しいです。代々木公園で遊んだ時は必ず寄ります。', 'https://fuglencoffee.jp/', 'fuglencoffee_IMG.jpg', now(), '3'); commit;5. 画面の作成

Databaseに保持した情報を出力するWebアプリケーションを作成します。

簡単な一覧画面と詳細画面を作成します。5-1. 一覧画面の作成

(1) src/appの配下に"templates"ディレクトリを作成し、

"templates"ディレクトリ配下に""list.html"を作成します。$ mkdir -p src/app/templates $ touch src/app/templates/list.html(2) src/app/templates/list.htmlを開き、以下の内容で保存します。

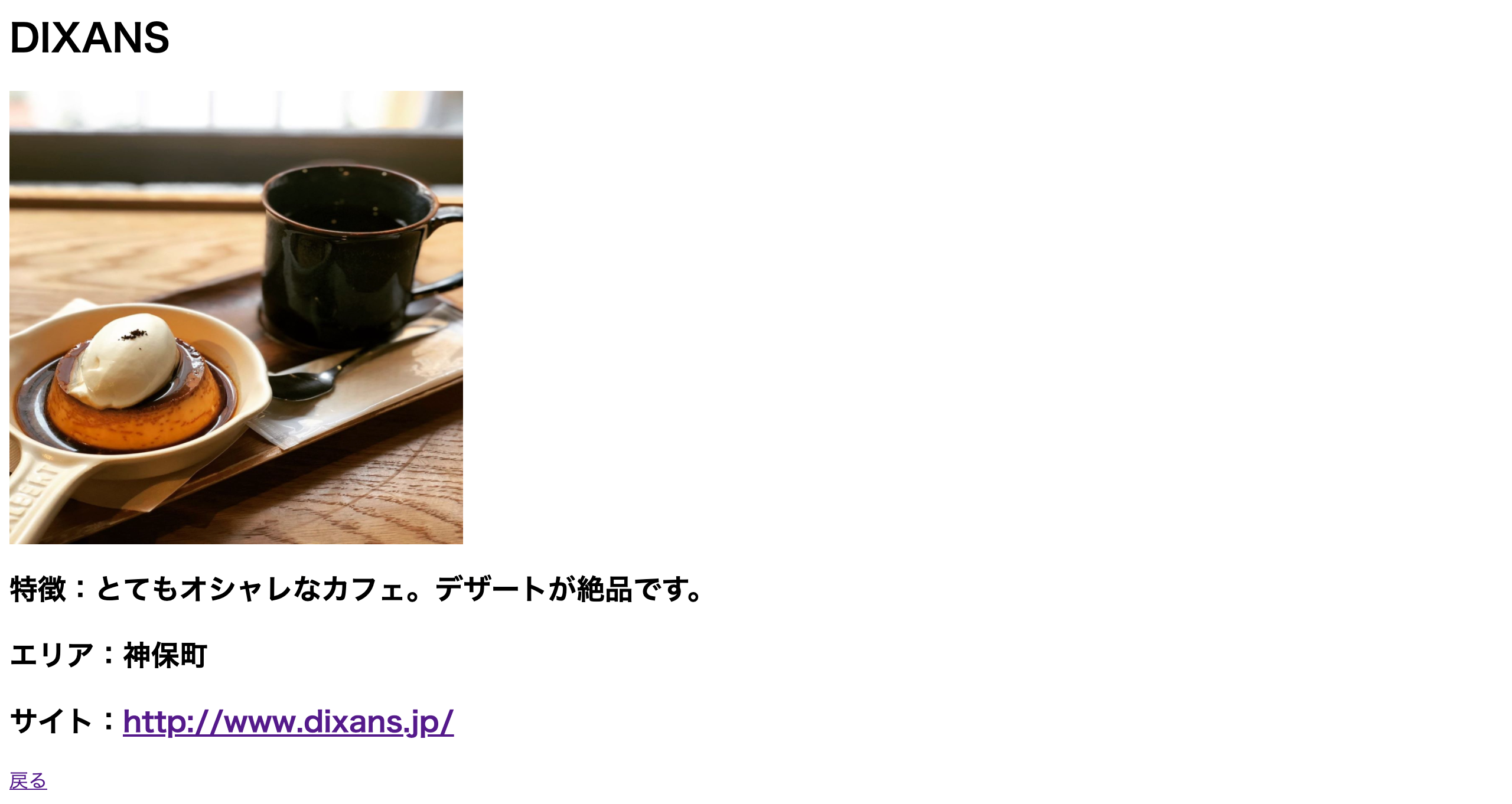

{% load static %} <html lang="ja"> <head> <meta charset="utf-8"> <link rel="stylesheet" type="text/css" href="{% static 'app_css/style.css' %}"> <link rel="shortcut icon" href="{% static 'pj_image/armx8-1ibhc-001.ico' %}" type="image/vnd.microsoft.icon"> </head> <body> <table border="1"> <thead> <tr> <th>カフェ</th> <th>特徴</th> <th>エリア</th> <th>サイト</th> </tr> </thead> <tbody> {% for cafe in cafe_list %} <tr> <td><a href="{% url 'app:detail' cafe.id %}">{{ cafe.name }}</a></td> <td>{{ cafe.memo }}</td> <td>{{ cafe.area.name }}</td> <td><a href="{{ cafe.website }}">{{ cafe.website }}</a></td> </tr> {% endfor %} </tbody> </table> </body> </html>5-2. 詳細画面の作成

(1) src/app/templatesの配下に"detail.html"を作成します。

$ touch src/app/templates/detail.html(2) src/app/templates/detail.htmlを開き、以下の内容で保存します。

{% load static %} <html lang="ja"> <head> <meta charset="utf-8"> <link rel="stylesheet" type="text/css" href="{% static 'app_css/style.css' %}"> <link rel="shortcut icon" href="{% static 'pj_image/armx8-1ibhc-001.ico' %}" type="image/vnd.microsoft.icon"> </head> <body> <h1>{{ cafe.name }}</h1> <h2><img src="{% static 'app_image/' %}{{ cafe.image_path }}" alt="{{ cafe.name }}のイメージ" title="{{ cafe.name }}のイメージ" width="384" height="384"></h2> <h2>特徴:{{ cafe.memo }}</h2> <h2>エリア:{{ cafe.area.name }}</h2> <h2>サイト:<a href="{{ cafe.website }}">{{ cafe.website }}</a></h2> <a href="{% url 'app:list' %}">戻る</a> </body> </html>5-3. ビューの編集

3-2.で作成した"Hello world."を出力するファイルを編集します。

src/app/views.pyを開き、以下の修正を行い保存します。(修正前)

from django.http import HttpResponse def index(request): return HttpResponse("Hello world.")(修正後)

from django.http import HttpResponse, HttpResponseRedirect from django.shortcuts import get_object_or_404, render from django.urls import reverse from django.views import generic from .models import Area, Cafe, Utility class IndexView(generic.ListView): template_name = 'list.html' context_object_name = 'cafe_list' def get_queryset(self): """Return the last five published records.""" return Cafe.objects.order_by('name')[:5] class DetailView(generic.DetailView): model = Cafe template_name = 'detail.html'5-4. URLの対応付け

3-3.で作成したURLを対応付けするファイルを編集します。

src/app/urls.pyを開き、以下の修正を行い保存します。

※ path()を追加し、新しいviewを app.urls モジュールと結びつけます。(修正前)

from django.urls import path from . import views urlpatterns = [ path('', views.index, name='index'), ](修正後)

from django.urls import path from django.contrib.auth.views import LoginView from . import views app_name = 'app' urlpatterns = [ path('', views.IndexView.as_view(), name='list'), path('<int:pk>/', views.DetailView.as_view(), name='detail'), ]5-5. 静的ファイルの設置

(1) appアプリケーションの静的ファイルのディレクトリを作成します。

$ mkdir -p src/app/static/app_css $ mkdir -p src/app/static/app_image $ mkdir -p src/app/static/app_js(2) appアプリケーションのcssを作成します。

src/app/static/app_css/style.cssを新規に作成し、以下の内容を記述します。table { background-color: #ffffff; border-collapse: collapse; /* セルの線を重ねる */ } th { background-color: #000080; color: #ffffff; /* 文字色指定 */ } th, td { border: solid 1px; /* 枠線指定 */ padding: 10px; /* 余白指定 */ }(3) DBに登録したCafeの画像ファイルをsrc/app/static/app_imageに配置します。

※ 画像ファイルは何でも良いので用意して下さい。

無くても、画像ファイルが表示されないだけなのでスキップしても問題ありません。

(4) mainprojectプロジェクトの静的ファイルのディレクトリを作成します。$ mkdir -p src/mainproject/static/pj_css $ mkdir -p src/mainproject/static/pj_image $ mkdir -p src/mainproject/static/pj_js

(5) faviconをsrc/mainproject/static/pj_imageに配置します。

※ faviconは何でも良いので用意して下さい。

無くても、faviconが表示されないだけなのでスキップしても問題ありません。

(6) 静的ファイルの収集を行う。

以下のコマンドを実行します。$ docker-compose run web ./manage.py collectstatic下記のようなメッセージが出力され、

「2-11. ALLOWED_HOST、DB及び静的ファイルの設定を行う。」で説明した通り、

STATICFILES_DIRSで指定した共通の静的ファイルと

各アプリケーション配下のstaticディレクトリの静的ファイルを収集します。

→ src/app/static/app_css/style.cssと

src/app/static/app_imageに配置した画像ファイルと

src/mainproject/static/pj_imageのfaviconが

src/staticにコピーされます。$ docker-compose run web ./manage.py collectstatic Starting container.postgres ... done 137 static files copied to '/code/static'.5-6. 動作確認

ブラウザを開き、"http://0.0.0.0:8000/app/"にアクセスし、

一覧画面と詳細画面が下記のように表示されていることを確認します。

(1) 一覧画面

NGINX、uWSGI、PostgreSQLが動作するDocker コンテナで、

DjangoのWebアプリケーションを動作確認するまでの手順が完了です。

Webアプリケーションを作る上で、基本的なことは紹介できたと思いますので、

本投稿が役に立てば幸いです。6. 参考情報(Django Admin)

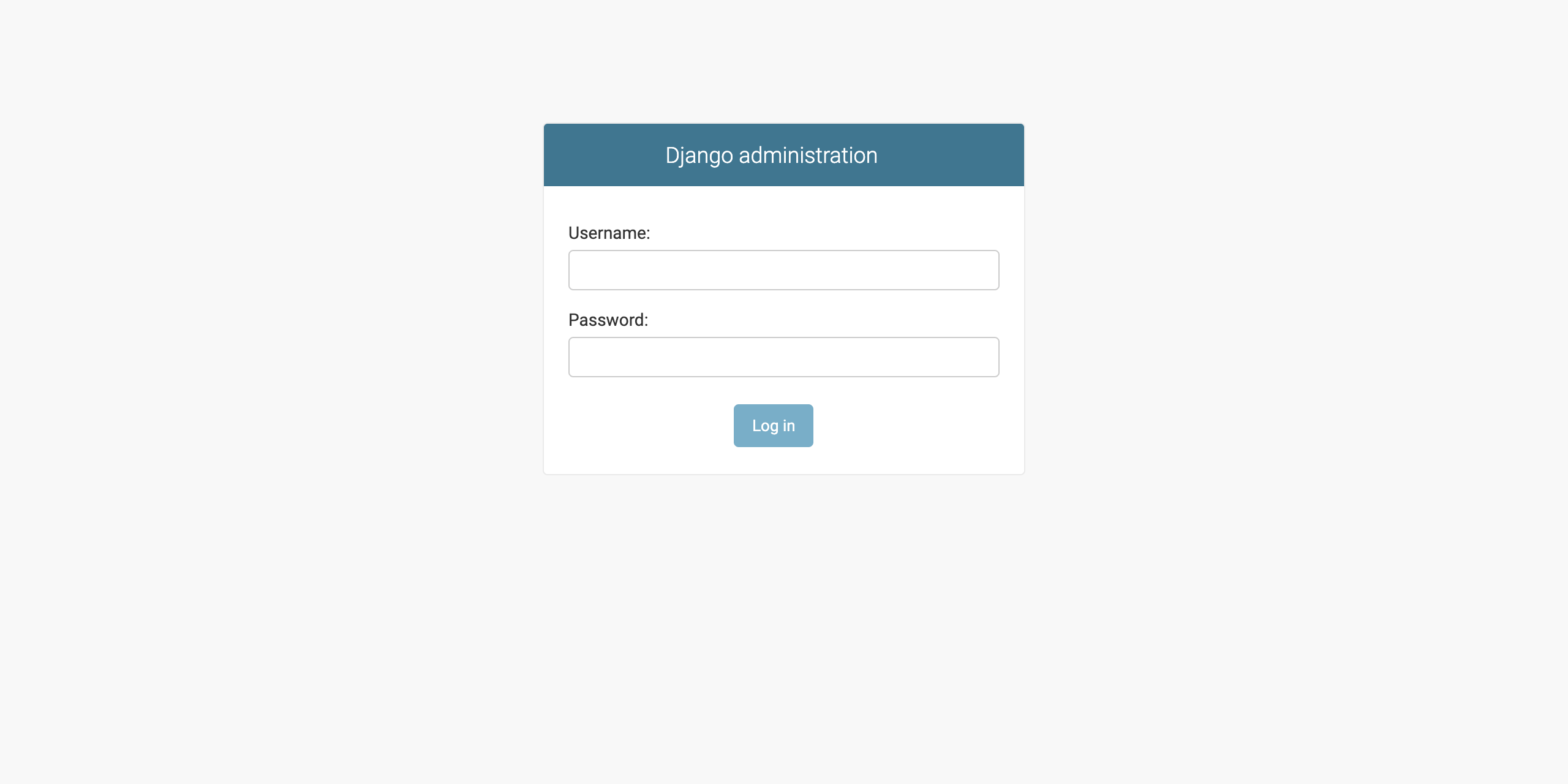

本投稿では、DBeaverを使ってデータの登録を行いましたが、Django Adminという

Djangoに用意されている管理画面を使ってデータを登録することも可能です。6-1. 管理ユーザの作成

以下のコマンドを実行します。

$ docker-compose run --rm web python manage.py createsuperuserコマンドプロンプトで以下のように任意の情報を入力します。

Username:admin

Email address:admin@example.com

Password:admin$ docker-compose run --rm web python manage.py createsuperuser Starting container.postgres ... done Username (leave blank to use 'root'): admin Email address: admin@example.com Password: Password (again): The password is too similar to the username. This password is too short. It must contain at least 8 characters. This password is too common. Bypass password validation and create user anyway? [y/N]: y Superuser created successfully.6-2. モデルをDjango Adminに登録

「4-1. モデルの作成」で作成したモデルをDjango Adminで編集できるようにします。

src/app/admin.pyを開き、以下の修正を行い保存します。

(修正前)

from django.contrib import admin # Register your models here.(修正後)

from django.contrib import admin from .models import Area from .models import Cafe from .models import Utility admin.site.register(Area) admin.site.register(Cafe) admin.site.register(Utility)6-3. 動作確認

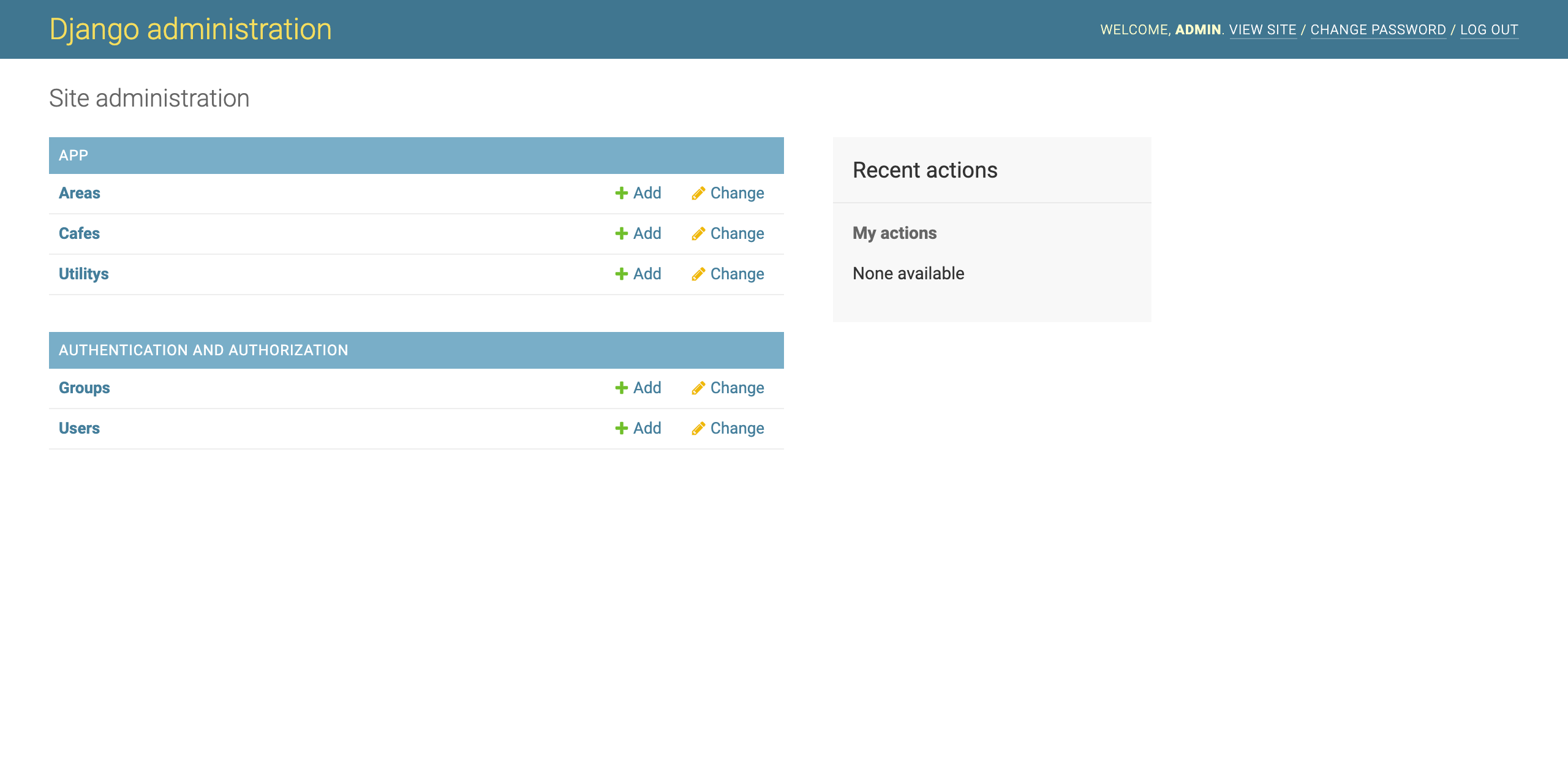

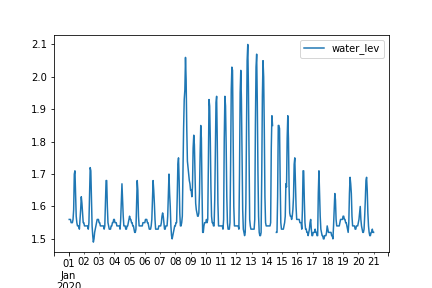

ブラウザを開き、"http://0.0.0.0:8000/admin/"にアクセスします。

Django Adminのログイン画面が開くので、

「6-1. 管理ユーザの作成」で作成した管理ユーザでログインして下さい。

ログイン後、Area、Cafe、Utilityのモデルの参照、追加、更新が出来ることを確認して下さい。7. 参考情報(Bootstrap4)

Bootstrap4を使用する方法を説明します。

「2-3. requirements.txtの設定」で説明した通り、

DjangoでBootstrap4を利用するためのパッケージをインストールしていますので、

以下の手順を行うことで、Bootstrap4のcss、Javascriptの利用が可能です。7-1. django-bootstrap4の設定

src/mainproject/settings.pyを開き、以下の修正を行い保存します。

(1) INSTALLED_APPSにdjango-bootstrap4を追加します。

(修正前)

INSTALLED_APPS = [ 'app.apps.AppConfig', 'django.contrib.admin', 'django.contrib.auth', 'django.contrib.contenttypes', 'django.contrib.sessions', 'django.contrib.messages', 'django.contrib.staticfiles', ](修正後)

INSTALLED_APPS = [ 'app.apps.AppConfig', 'django.contrib.admin', 'django.contrib.auth', 'django.contrib.contenttypes', 'django.contrib.sessions', 'django.contrib.messages', 'django.contrib.staticfiles', 'bootstrap4', ](2) TEMPLATESのbuiltinsにbootstrap4.templatetags.bootstrap4を追加します。

※ これを追加することで、各htmlに{% load bootstrap4 %}を記述する必要がなくなります。(修正前)

TEMPLATES = [ { 'BACKEND': 'django.template.backends.django.DjangoTemplates', 'DIRS': [], 'APP_DIRS': True, 'OPTIONS': { 'context_processors': [ 'django.template.context_processors.debug', 'django.template.context_processors.request', 'django.contrib.auth.context_processors.auth', 'django.contrib.messages.context_processors.messages', ], }, }, ](修正後)

TEMPLATES = [ { 'BACKEND': 'django.template.backends.django.DjangoTemplates', 'DIRS': [], 'APP_DIRS': True, 'OPTIONS': { 'context_processors': [ 'django.template.context_processors.debug', 'django.template.context_processors.request', 'django.contrib.auth.context_processors.auth', 'django.contrib.messages.context_processors.messages', ], 'builtins':[ 'bootstrap4.templatetags.bootstrap4', ], }, }, ]7-2. Utilityテーブルに制御フラグを追加(おまけ①)

UtilityテーブルにBootstrap4のcssを利用するかしないかを制御するデータを追加します。

このデータを使って、一覧画面のhtmlでBootstrap4のcssを読み込むか読み込まないか判別します。

* 使用しない場合、value列の値を”1”以外に設定します。insert into app_utility (key, value, create_date) values ('bootstrap_flg', '1', now()); commit;7-3. 一覧画面の修正

(1) src/mainproject/settings.pyを開き、以下の修正を行い保存します。(おまけ②)

get_context_dataを使って、「7-2. Utilityテーブルに制御フラグを追加」で

追加したデータをhtmlで利用できるようにしています。(修正前)

from django.http import HttpResponse, HttpResponseRedirect from django.shortcuts import get_object_or_404, render from django.urls import reverse from django.views import generic from .models import Area, Cafe, Utility class IndexView(generic.ListView): template_name = 'list.html' context_object_name = 'cafe_list' def get_queryset(self): """Return the last five published records.""" return Cafe.objects.order_by('name')[:5] class DetailView(generic.DetailView): model = Cafe template_name = 'detail.html'(修正後)

from django.http import HttpResponse, HttpResponseRedirect from django.shortcuts import get_object_or_404, render from django.urls import reverse from django.views import generic from .models import Area, Cafe, Utility class IndexView(generic.ListView): template_name = 'list.html' context_object_name = 'cafe_list' def get_queryset(self): """Return the last five published records.""" return Cafe.objects.order_by('name')[:5] def get_context_data(self, **kwargs): context = super().get_context_data(**kwargs) context["bootstrap_flg"] = Utility.objects.all().filter(key='bootstrap_flg').first() return context class DetailView(generic.DetailView): model = Cafe template_name = 'detail.html'(2) src/app/templates/list.htmlを開き、以下の修正を行い保存します。

bootstrap_flg.value == "1"の時に、{% bootstrap_css %}を読み込むように記述しています。

今回、おまけ①②をすることで、テーブルのデータによって、

Bootstrap4のcssを読み込むか制御できるように対応しましたが、

単純に使用したい場合は、おまけ①②は飛ばし、{% bootstrap_css %}を

htmlに追加するだけで使用が可能です。

(修正前){% load static %} <html lang="ja"> <head> <meta charset="utf-8"> <link rel="stylesheet" type="text/css" href="{% static 'app_css/style.css' %}"> <link rel="shortcut icon" href="{% static 'pj_image/armx8-1ibhc-001.ico' %}" type="image/vnd.microsoft.icon"> </head> <body> <table border="1"> <thead> <tr> <th>カフェ</th> <th>特徴</th> <th>エリア</th> <th>サイト</th> </tr> </thead> <tbody> {% for cafe in cafe_list %} <tr> <td><a href="{% url 'app:detail' cafe.id %}">{{ cafe.name }}</a></td> <td>{{ cafe.memo }}</td> <td>{{ cafe.area.name }}</td> <td><a href="{{ cafe.website }}">{{ cafe.website }}</a></td> </tr> {% endfor %} </tbody> </table> </body> </html>(修正後)

{% load static %} <html lang="ja"> <head> <meta charset="utf-8"> <link rel="stylesheet" type="text/css" href="{% static 'app_css/style.css' %}"> {% if bootstrap_flg.value == "1" %} {% bootstrap_css %} {% endif %} <link rel="shortcut icon" href="{% static 'pj_image/armx8-1ibhc-001.ico' %}" type="image/vnd.microsoft.icon"> </head> <body> <table border="1"> <thead> <tr> <th>カフェ</th> <th>特徴</th> <th>エリア</th> <th>サイト</th> </tr> </thead> <tbody> {% for cafe in cafe_list %} <tr> <td><a href="{% url 'app:detail' cafe.id %}">{{ cafe.name }}</a></td> <td>{{ cafe.memo }}</td> <td>{{ cafe.area.name }}</td> <td><a href="{{ cafe.website }}">{{ cafe.website }}</a></td> </tr> {% endfor %} </tbody> </table> </body> </html>7-4. 動作確認

ブラウザを開き、"http://0.0.0.0:8000/app/"にアクセスし、

一覧画面にBootstrap4のcssが使用されていることを確認します。参考元

Compose file version 3 reference

Docker Composeチュートリアル: herokuのPostgresをローカルにさくっとコピーする

Supported tags and respective Dockerfile links

はじめての Django アプリ作成、その 1

SQLのSELECT文を、DjangoのQuerySet APIで書いてみた

Djangoにおけるクラスベース汎用ビューの入門と使い方サンプル

- 投稿日:2020-03-22T22:35:17+09:00

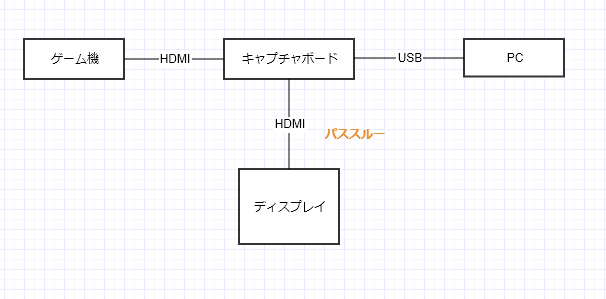

Fortniteの画像を100枚スクレイピングする

Fortniteの画像を、Yahooから100枚スクレイピングしてみた。

・Mac

・python3(1)環境構築、ディレクトリ構成

デスクトップにディレクトリfortniteを作成。

ディレクトリ内にimagesフォルダ(画像保存用)と、scraping.pyを作成。fortnite ├scraping.py └imagesディレクトリ内で仮想環境構築。

python3 -m venv . sorce bin/activate必要なパッケージ、モジュールをインストール

pip install beautifulsoup4 pip install requests pip install lxml(2)scraping.pyを記述

Fortniteの画像スクレイピングは、Yahooの画像検索結果を使う。

https://search.yahoo.co.jp/image/search?p=%E3%83%95%E3%82%A9%E3%83%BC%E3%83%88%E3%83%8A%E3%82%A4%E3%83%88&ei=UTF-8&b=1

1ページあたり10枚画像あり、次ページ以降を合わせると100枚以上はあることが確認できる。

ここからスクレピングして、imagesフォルダに格納する。scraping.pyfrom bs4 import BeautifulSoup import lxml import requests import os import time def main(): #1ページあたり20個の画像、次ページをスクレイピングするための変数 page_key=0 #保存した画像をナンバリングするための変数 num_m = 0 for i in range(6): URL = "https://search.yahoo.co.jp/image/search?p=%E3%83%95%E3%82%A9%E3%83%BC%E3%83%88%E3%83%8A%E3%82%A4%E3%83%88&ei=UTF-8&b={}".format(page_key + 1) res = requests.get(URL) res.encoding = res.apparent_encoding html_doc = res.text soup = BeautifulSoup(html_doc,"lxml") list = [] _list = soup.find_all("div",class_="gridmodule") for i in _list: i2 = i.find_all('img') for i3 in i2: i4 = i3.get('src') list.append(i4) for i in list: i2 = requests.get(i) #絶対パスを指定して保存 with open(os.path.dirname(os.path.abspath(__file__)) + '/images' + '/{}'.format(num_m)+'.jpeg','wb')as f: f.write(i2.content) num_m += 1 #画像が101枚目となったら保存処理を停止(for文停止) if num_m == 101: break #保村処理のfor文が停止した場合、for文を停止する処理 else: continue break #サーバー負荷防止のため1秒間隔を開ける time.sleep(1) page_key+=20 if __name__ == '__main__': main()補足説明

・GoogleChromeの”検証”を使い、画像URLのありそうな場所を探した結果、divタグのclassがgridmoduleの部分にあることを確認。そこからimgタグの部分をスクレイピング。

・get('src')で、imgタグのsrc属性の値を取得する。

・取得したimgタグのsrc属性はurlではあるものの、str型となっているので、requestsでレスポンス情報を格納したレスポンスオブジェクトを取得する。レスポンスオブジェクトには、text、encoding、status_code、contentが含まれる。contentはレスポンスボディをバイナリ形式で取得するために必要。(参考)Requests の使い方 (Python Library)

・ファイルで絶対パスを指定して、wbモードで書き込む(参考)

Python、os操作について

・for文で100枚保存したら内側のfor文と外側のfor文を中止する。Pythonのforループのbreak(中断条件)実行すると、imagesフォルダに画像を保存できたことが確認できる。

- 投稿日:2020-03-22T22:15:04+09:00

Splunkでカスタムサーチコマンドを作成する

Splunkのサーチバーで使うコマンドが自作できると聞いたので試してみました。ちなみに、Splunkでは自作したコマンドを「カスタムサーチコマンド」と呼ぶらしい。

作成するカスタムサーチコマンドのイメージ

今回作成するカスタムサーチコマンドは、新規フィールド

new_numberを作成して、その値に「別フィールドnumberに書かれている値に1を加えた数」を入れる、というものにしました。今回使用する元データを下に示します。カスタムサーチコマンドを登録する

プログラムを作成する前にまず登録を行います。登録するには、

/opt/splunk/etc/apps/search/local/commands.confに以下のような文を追加します。Splunkの初回インストールの直後は、

/opt/splunk/etc/apps/search/配下にlocalフォルダすらないので、localフォルダを作成しcommands.confも新規作成します。/opt/splunk/etc/apps/search/local/commands.conf[hoge] filename = test.py streaming = true[ ]で囲まれた中の文字がサーチバーで記載するカスタムサーチコマンド名になり、このコマンドが呼び出されると

filename=で書かれているプログラム名を実行します。なお、Streamingの値により動作が多少変わります。

streamingの値 動作 True 前のSPLの結果を50件づつ区切ってプログラムに渡す False 前のSPLの全結果をプログラムを渡す カスタムサーチコマンドの本体の作成

プログラムの本体は

/opt/splunk/etc/apps/search/bin/のフォルダに作成します。プログラム名はcommands.confに記入したプログラム名test.pyと同じにします。/opt/splunk/etc/apps/search/bin/test.pyimport splunk.Intersplunk data,dummy1,dummy2 = splunk.Intersplunk.getOrganizedResults(input_str=None) for tmp in data: tmp['new_number'] = int(tmp['number']) + 1 splunk.Intersplunk.outputResults(data)作成が完了したら、splunkの設定からSplunkを再起動します。

test.pyは再起動しなくても変更が反映されますが、commands.confは再起動しないと変更が反映されません。プログラムの実行

下のSPLを実行すると、

host = test | hoge | table number new_numberおわりに

ちょこっとだけ調べたのですが、関数