- 投稿日:2020-02-25T23:55:10+09:00

Pythonで関数を作る

Pythonでの関数の作り方を自分用のメモとして置いておきます。

定義

関数名をfunctionとする。

def function(): pass #引数なし引数

関数にデータ(int,str,class等)を渡す。

引数(ひきすう)名をargsとする。def function(args): #引数あり print(args) def function2(args1,args2): #引数は何個でも取れる print(args,args2) def function3(args="Hello World"): #引数に初期値を設定できる #呼び出し時に引数がなければargsには"Hello World"が入る print(args)戻り値

関数内の処理の結果を返す。

def function(args): #戻り値あり n = args * 2 #引数を2倍して返す return n def function2(args,args2): a = args + args2 b = args - args2 return (a,b) #タプル型で返す返す型は何でもいい

呼び出し

関数を呼び出すには 関数名() で呼び出せる。

def function(): print("Hello World") function() #------------ #Hello World #------------引数がない場合は()内に何も書かなくていい。

書くとエラーが出る。TypeError: function() takes 0 positional arguments but 1 was given引数

引数は()の中に書く。

def function(args): print(args) function("Hello World") #------------ #Hello World #------------引数を設定しないとTypeErrorが起きる。

TypeError: function() missing 1 required positional argument: 'args'戻り値

戻り値は変数に入れることができる。

def function(args): n = args * 2 return n n = function(5)#function関数の戻り値を変数nに代入 print(n) #-------- #10 #--------その他

関数内から別の関数を呼ぶこともできる。

def function(args): n = function2(args,10)#function関数内からfunction2関数の呼び出し print(n) def function2(args,args2): n = args * args2 return n function(5) #-------- #50 #--------

- 投稿日:2020-02-25T23:10:13+09:00

【Docker】チュートリアル(Python+php)

はじめに

Dockerを勉強するにあたり、素晴らしいチュートリアル動画があったのでそれを元に自分で手を動かして見ました。リンク先の動画は英語ですので、日本語で少し補足をしながら進めていきます。初心者のため認識の誤りがあるかもしれませんので、その際はコメント頂けると幸いです。

事前にdocker、docker-composeのインストールが必要です。

元動画

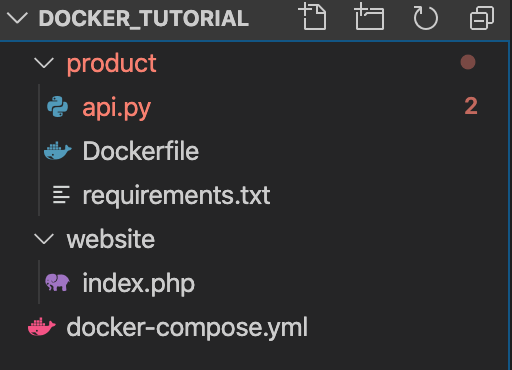

productディレクトリにはjsonを返すAPIをpythonで用意します。

websiteディレクトリには画面を描画するphpを用意します。product

まずはdocker_tutorial配下にproductディレクトリを作成します。

$ mkdir productそしてシンプルなPythonコードを作成します。flaskとflask_restfulというライブラリを使用します。

api.pyfrom flask import Flask from flask_restful import Resource, Api app = Flask(__name__) api = Api(app) class Product(Resource): def get(self): return{ 'products': [ 'Ice cream', 'Chocolate', 'Fruit' ] } api.add_resource(Product, '/') if __name__ == '__main__': app.run(host='0.0.0.0', port=80, debug=True)ローカル環境にpythonをインストールしている場合は、pip installなどでライブラリをインストールしますが、Dockerを使用した場合は個別にインストールする必要はありません。その代わりにコンテナ起動時に必要となるライブラリなどを以下のテキストファイルに記載するか、後述のDockerfile内にpip installのコマンドを記載します。バージョンはライブラリの公式サイトなどを参照して使用したいバージョンを記載します。

requirements.txtFlask==0.12 flask-restful==0.3.5次にDockerfileを作成します。

DockerfileはDocker上で動作させるコンテナの構成情報を記述するためのファイルです。FROM python:3-onbuild COPY . /usr/src/app CMD ["python", "api.py"]FROM

FROMにはベースとするDockerイメージを指定します。また「onbuild」を記載することで、Dockerfile を使って docker build をするとき、Dockerfile 内で pip install を書かなくても Dockerfile と同じディレクトリに requirements.txt があると自動的にインストールをするようになっています。COPY

COPYにはローカルファイルをDockerイメージのどこにコピーするかを記載します。今回の場合はproductディレクトリをDocker上の/usr/src/app内にコピーします。CMD

CMDにはコンテナ起動時に実行するコマンドを記載します。次にdocker-compose.ymlを作成します。docker-composeには

- Dockerイメージをビルドするための情報(使用するDockerfile、イメージ名など)

- コンテナ起動するための情報(ホストとの共有ディレクトリ設定やポートフォワードなどの起動オプションなど)

- 使用するDockerネットワーク

などを記載します。

docker-compose.ymlversion: '3' services: product-service: build: ./product volumes: - ./product:/usr/src/app ports: - 5001:80version

docker-composeで使用するバージョンを記載します。現在はバージョン3が最新ですので、3を指定します。services

アプリケーションを動かすための各要素をServiceと読んでいます。各サービスをネストしてこちらに記載します。今回の場合は「product-service」というサービスを起動します。build

指定したディレクトリにあるDockerfileでコンテナを起動します。今回の場合はproductディレクトリのDockerfileでコンテナを起動します。volumes

ローカリのディレクトをコンテナのディレクトにマウントします。今回の場合はproductディレクトリをコンテナ上の/usr/src/appディレクトリにマウントします。ports

Dockerを立ち上げるポート番号を記載します。今回は5001番ポートで立ち上げます。それではDockerを起動

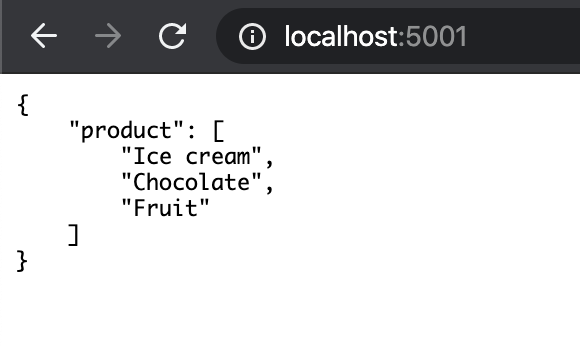

$ docker-compose up起動が完了したら、localhost:5001にアクセスします。

以下のような画面が表示されたら問題なく起動しています。

ここまでで、簡単にPython、Flaskの環境ができることが分かります。この状態でapi.pyを以下のように変更し、保存します。

api.pyclass Product(Resource): def get(self): return{ 'products': [ 'Ice cream', 'Chocolate', 'Fruit', 'Eggs' ] }再読み込みを行うと、表示内容も更新されます。コンテナを再起動しなくてもマウントしてくれます。

ここまできたらコンソール上で「control+C」を押して、dockerを一旦停止します。

website

次はdocker_tutorial配下にwebsiteというディレクトリを作成します。こちらにはphpのファイルを作成します。

http://product-serviceの結果をループして表示する処理です。

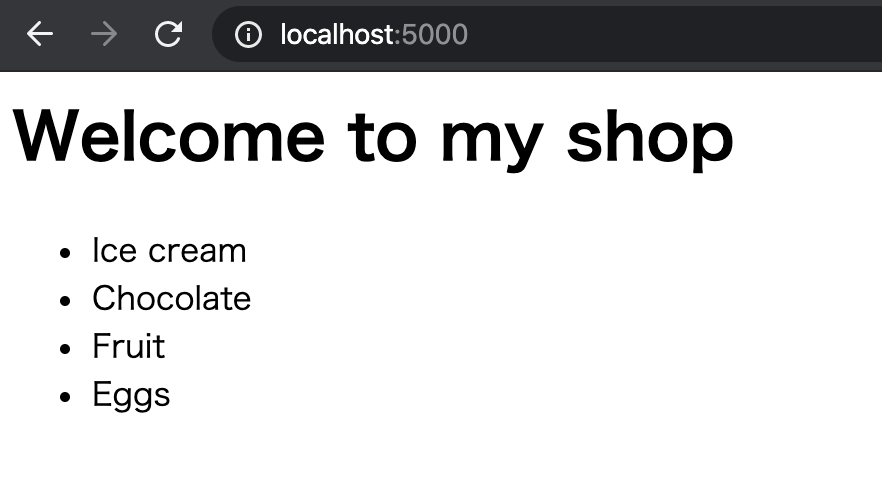

ここでいうproduct-serviceはdocker-composeに記載したサービス名が該当します。index.php<html> <head> <title>My Shop</title> </head> <body> <h1>Welcome to my shop</h1> <ul> <?php $json = file_get_contents('http://product-service'); $obj = json_decode($json); $products = $obj->products; foreach($products as $product) { echo "<li>$product</li>"; } ?> </ul> </body>次にdocker-compose.ymlを以下のように変更します。

docker-compose.ymlversion: '3' services: product-service: build: ./product volumes: - ./product:/usr/src/app ports: - 5001:80 website: image: php:apache volumes: - ./website:/var/www/html ports: - 5000:80 depends_on: - product-servicewebsite

servicesにwebsiteというサービスを追加します。image

imageを記載することで、Docker Hub上に用意されている既存のイメージを使用することができます。buildとimageは同時に指定することはできません。depends_on

サービス同士の依存関係を記載します。今回の場合、websiteが実行されるより前にproduct-serviceが実行されるようになります。docker-compose.ymlにproduct-serviceがない場合はエラーになります。再度Dockerを起動します。

$ docker-compose up起動が完了したらlocalhost:5000にアクセスします。

以下のような画面が表示されていれば成功です。さいごに

Dockerを使用することで、簡単にPython+phpの環境を作ることができました。私もDocker初心者のためこれからも引き続き学習していきたいと思います。

おまけ

-dをつけることでバックグラウンドでコンテナを立ち上げることができます。

$ docker-compose up -d Starting docker_tutorial_product-service_1 ... done Starting docker_tutorial_website_1 ... donepsコマンドで起動中のコンテナの一覧が確認できます。

$ docker ps CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 24de043f94d9 php:apache "docker-php-entrypoi…" 10 minutes ago Up About a minute 0.0.0.0:5000->80/tcp docker_tutorial_website_1 da62924c1154 docker_tutorial_product-service "python api.py" 32 minutes ago Up About a minute 0.0.0.0:5001->80/tcp docker_tutorial_product-service_1stopでコンテナを停止することができます。

$ docker-compose stop Stopping docker_tutorial_website_1 ... done Stopping docker_tutorial_product-service_1 ... done $ docker ps ONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES参考

- 投稿日:2020-02-25T22:59:09+09:00

機械学習のアルゴリズム(線形回帰まとめ&正則化)

はじめに

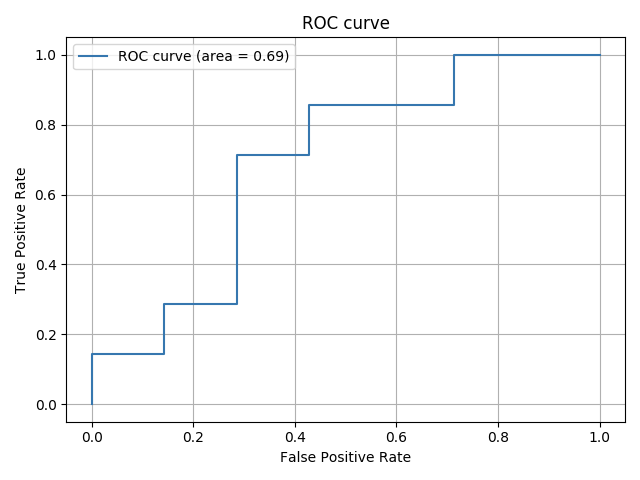

以前、「機械学習の分類」で取り上げたアルゴリズムについて、その理論とpythonでの実装、scikit-learnを使った分析についてステップバイステップで学習していく。個人の学習用として書いてるので間違いなんかは大目に見て欲しいと思います。

今回は、線形回帰編のまとめとしてガウシアンカーネルを使った線形近似と、過学習やそれを抑えるL1正則化(Lasso)、L2正則化(Ridge)についてまとめてみようと思う。

今回参考にしたのは以下のサイト。ありがとうございます。

- 線形な手法とカーネル法(1. 回帰分析)

- リッジ回帰とラッソ回帰の理論と実装を初めから丁寧に

- 正則化項(LASSO)を理解する

- ラッソ回帰を実装してみよう

- scikit-learnで線形モデルとカーネルモデルの回帰分析をやってみた - イラストで学ぶ機会学習

カーネル近似について

以前、線形回帰の一般化について書いた時に、「基底関数はなんでもよい」と書いた。現実の回帰でも常に直線で近似できるとは限らず、多項式や三角関数のようなクネクネした近似というのも必要になってくる。

例えば$y=-xsin(x)$にノイズを乗せた$y=-xsin(x)+\epsilon$について考える、

import numpy as np import pandas as pd import matplotlib.pyplot as plt %matplotlib inline fig, ax = plt.subplots() t = np.linspace(0, 2*np.pi, 100) y1 = - t * np.sin(t) n=40 np.random.seed(seed=2020) x = 2*np.pi * np.random.rand(n) y2 = - x * np.sin(x) + 0.4 * np.random.normal(loc=0.0, scale=1.0, size=n) ax.scatter(x, y2, color='blue', label="sample(with noise)") ax.plot(t, y1, color='green', label="-x * sin(x)") ax.legend(bbox_to_anchor=(1.05, 1), loc='upper left', borderaxespad=0, fontsize=11) plt.show()青い点がノイズを乗せたサンプルで、緑の実線が想定する関数を示している。ノイズは乱数で加えたが、毎回同じ結果になるように乱数のシード値は固定した。

今回は目的関数がわかっているのでよいが、サンプルが多項式なのかそれとも別な関数なのかはわからない状態から推定しなければならない。

ガウスカーネルついて

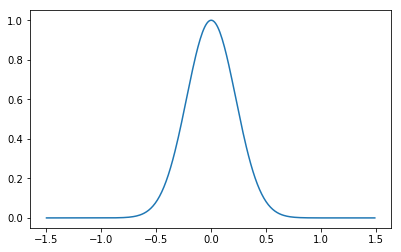

ガウスカーネルは次のように定義されます。

k(\boldsymbol{x}, \boldsymbol{x'})=\exp(-\beta||\boldsymbol{x}-\boldsymbol{x'}||^2)$||\boldsymbol{x}-\boldsymbol{x'}||^2$はベクトル同士の距離で、$\sqrt{\sum_{j=1}^{n}(x_j-x'_j)^2} $とも表されます。

この関数は以下のような形をしており、この関数の中心を移動したり大きさを変えることで目的のデータ列に回帰させます。

ガウスカーネルを使った線形回帰

今、目的の関数を

f({\bf x})=\sum_{i=1}^{N} \alpha k({\bf x}^{(i)}, {\bf x}')とする。標本の値を$\hat{y}$とすると、

\hat{y} = \left(\begin{matrix} k({\bf x}^{(1)}, {\bf x}) & k({\bf x}^{(2)}, {\bf x}) & \cdots & k({\bf x}^{(N)}, {\bf x}) \end{matrix}\right) \left(\begin{matrix} \alpha_0 \\ \alpha_1 \\ \vdots \\ \alpha_N \end{matrix}\right)となり、

{\bf y} = \left(\begin{matrix} y^{(1)} \\ y^{(2)} \\ \vdots \\ y^{(N)} \end{matrix}\right) ,\; K=\left(\begin{matrix} k({\bf x}^{(1)}, {\bf x}^{(1)}) & k({\bf x}^{(2)}, {\bf x}^{(1)}) & \cdots & k({\bf x}^{(N)}, {\bf x}^{(1)}) \\ k({\bf x}^{(1)}, {\bf x}^{(2)}) & k({\bf x}^{(2)}, {\bf x}^{(2)}) & & \vdots \\ \vdots & & \ddots & \vdots \\ k({\bf x}^{(1)}, {\bf x}^{(N)}) & \cdots & \cdots & k({\bf x}^{(N)}, {\bf x}^{(N)}) \end{matrix}\right) ,\; {\bf \alpha} = \left(\begin{matrix} \alpha^{(1)} \\ \alpha^{(2)} \\ \vdots \\ \alpha^{(N)} \end{matrix}\right)という風に展開される(このへんコピペですすいません)。ここで$K$をグラム行列と呼ぶ。$f({\bf x})$と$\hat{y}$の二乗誤差$L$は

L=({\bf y}- K {\bf \alpha})^{\mathrm{T}}({\bf y}- K {\bf \alpha})となり、これを$\alpha$について解くと、$${\bf \alpha} = (K^{\mathrm{T}}K)^{-1}K^{\mathrm{T}}{\bf y} = K^{-1}{\bf y}$$となる。つまり、グラム行列の逆行列が計算できれば$\alpha$を求めることが可能ということになる。観測サンプル数が多すぎる場合、この逆行列を求めることが大変になるので別の方法を選ぶ必要がある。

pythonでの実装

上の式をそのまま使ってKernelRegressionクラスを実装した。

class KernelRegression: #正則化なし def __init__(self, beta=1): self.alpha = np.array([]) self.beta = beta def _kernel(self, xi, xj): return np.exp(- self.beta * np.sum((xi - xj)**2)) def gram_matrix(self, X): N = X.shape[0] K = np.zeros((N, N)) for i in range(N): for j in range(N): K[i][j] = self._kernel(X[i], X[j]) K[j][i] = K[i][j] return K def fit(self, X, Y): K = self.gram_matrix(X) self.alpha = np.linalg.inv(K)@Y def predict(self, X, x): Y = 0 for i in range(len(X)): Y += self.alpha[i] * self._kernel(X[i], x) return Y最初のサンプルを使って近似させてみる。

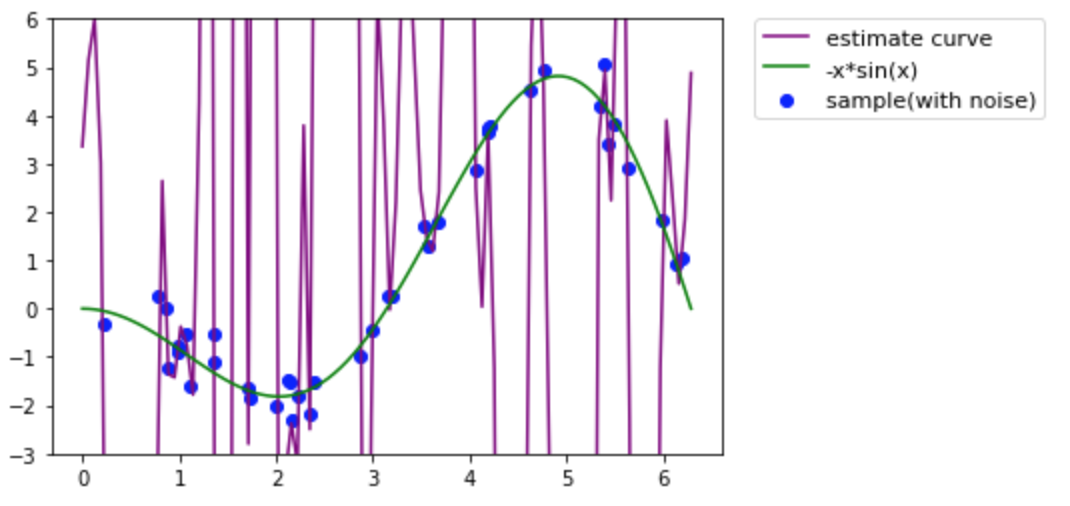

model = KernelRegression(beta=20) model.fit(x, y2) xp = np.linspace(0, 2*np.pi, 100) yp = np.zeros(len(xp)) for i in range(len(xp)): yp[i] = model.predict(x, xp[i]) fig, ax = plt.subplots() plt.ylim(-3,6) ax.plot(xp, yp, color='purple', label="estimate curve") ax.scatter(x, y2, color='blue', label="sample(with noise)") ax.plot(t, y1, color='green', label="-x*sin(x)") ax.legend(bbox_to_anchor=(1.05, 1), loc='upper left', borderaxespad=0, fontsize=11) plt.show()確かに与えられたサンプル上を通っているみたいですがグチャグチャです。緑の曲線とは全然違いますね。

過学習(overfitting)について

上のように学習の結果が教師データに対して忠実だが、現実とかけ離れてしまうことを過学習(overfitting)と言います。数学のテストで、教科書と同じ問題が出れば解けるけどちょっとアレンジされるととたんに解けなくなるのと似ているでしょうか。

過学習されたモデルのことを汎化性能がよくないとも言います。予測精度が低い状態です。これを防ぐために、正則化という概念が必要になります。

正則化(regularization)

上の例では、与えられたサンプルの点を無理やり通すために、パラメータ$\bf{\alpha}$が極端に大きくなっていることが原因で激しく暴れる曲線になってしまっています。あとは、データ数が極端に少なかったり、変数が多い場合にこうなってしまうことが多いようです。

これを防ぐためには、$\alpha$を求める際に、カーネル回帰の二乗誤差に正則化項を加えることで$\alpha$の範囲を制限することで実現できます。機械学習ではL1正則化(Lasso)とL2正則化(Ridge)が有名です。両者をミックスさせるとElasticNet正則化と呼ばれます。

L2正則化

L1ではなくL2から始めます。

先ほど$\alpha$を求めた際に目的関数とサンプルの二乗誤差を$L$とおきましたが、$\lambda||{\bf \alpha}||_2^2$を加えたL=({\bf y}- K {\bf \alpha})^{\mathrm{T}}({\bf y}- K {\bf \alpha})+\lambda||{\bf \alpha}||_2^2を最適化します。$\lambda$が大きいほど$\alpha$が制限されるため、よりおとなしい(?)曲線になります。これを$\alpha$で偏微分して0とおき、$\alpha$について解くと、

{\bf \alpha} = (K+\lambda I_N)^{-1}{\bf y}となります。これはグラム行列に単位行列を足して逆行列を計算するだけでよいので変更は簡単ですね。

pythonでの実装

先ほどのKernelRegressionクラスの$\alpha$を求める部分を若干変更しました。あとはほぼ同じです。

class KernelRegression: # L2正則化 def __init__(self, beta=1, lam=0.5): self.alpha = np.array([]) self.beta = beta self.lam = lam def _kernel(self, xi, xj): return np.exp(- self.beta * np.sum((xi - xj)**2)) def gram_matrix(self, X): N = X.shape[0] K = np.zeros((N, N)) for i in range(N): for j in range(N): K[i][j] = self._kernel(X[i], X[j]) K[j][i] = K[i][j] return K def fit(self, X, Y): K = self.gram_matrix(X) self.alpha = np.linalg.inv(K + self.lam * np.eye(X.shape[0]))@Y def predict(self, X, x): Y = 0 for i in range(len(X)): Y += self.alpha[i] * self._kernel(X[i], x) return Y正則化しなかった場合と同じサンプルを使って近似してみます。$\beta$や$\lambda$の数値は適当に決めました。

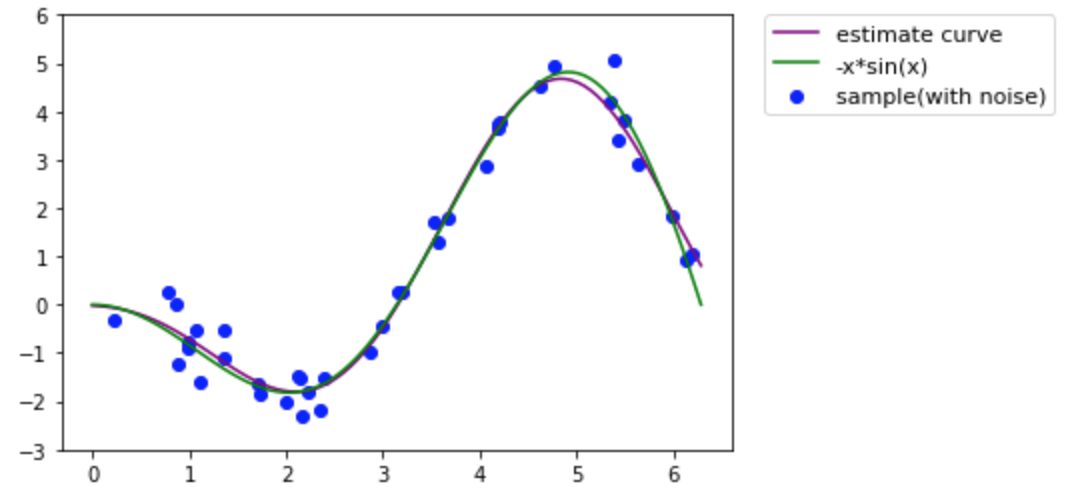

model = KernelRegression(beta=0.3, lam=0.1) model.fit(x, y2) xp = np.linspace(0, 2*np.pi, 100) yp = np.zeros(len(xp)) for i in range(len(xp)): yp[i] = model.predict(x, xp[i]) fig, ax = plt.subplots() plt.ylim(-3,6) ax.plot(xp, yp, color='purple', label="estimate curve") ax.scatter(x, y2, color='blue', label="sample(with noise)") ax.plot(t, y1, color='green', label="-x*sin(x)") ax.legend(bbox_to_anchor=(1.05, 1), loc='upper left', borderaxespad=0, fontsize=11) plt.show()今回は見事に一致しました。実際は表示している範囲外では形が変わってしまうんですが、特定の範囲においてはかなり近い近似曲線がひけることがご理解いただけたと思います。

$\beta$や$\lambda$はハイパーパラメータと呼ばれ、これらを少しずつ変えて損失関数の値を最小化するという最適化も実際には必要になりますね。

L1正則化

L2正則化では、正則化項として、$\lambda ||{\bf \alpha}||^2_{2} $を加えましたが、L2正則化では正則化項として$\lambda||{\bf \alpha}||_1$を加えます。

L1正則化では正則化項が微分できないため、解を求めるのは少し複雑です。scikit-learnでは座標降下法(Coordinate Descent)という手法で実装されているみたいですが、私がまだ理解できていないので、本稿では素直にscikit-learnを使いたいと思います。

L1正則化は、パラメータ$\alpha$のかなりの部分を0にすることができ(スパースな解を得る)、不要なパラメータを削ることに役立ちます。

pythonでの実装

素直にscikit-learnで実装してみます。

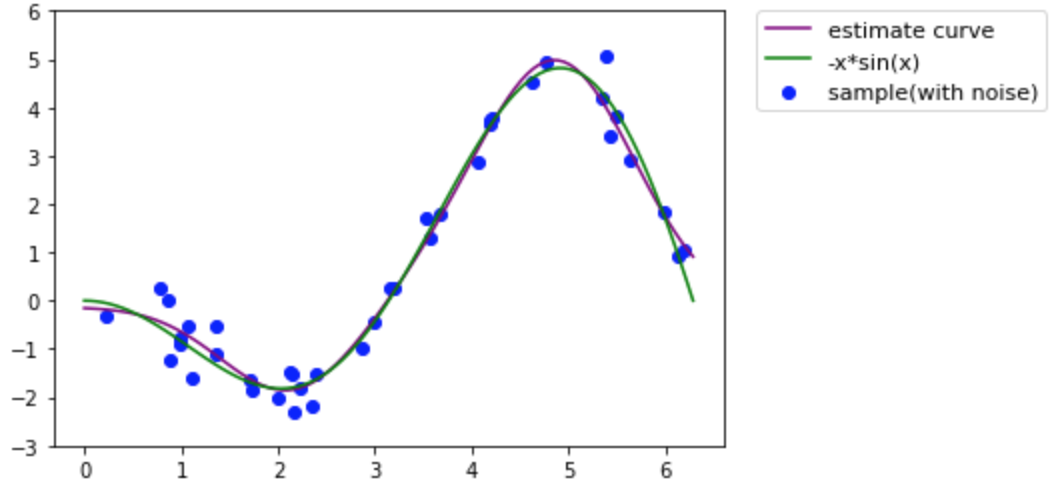

from sklearn.metrics.pairwise import rbf_kernel from sklearn.linear_model import Lasso kx = rbf_kernel(x.reshape(-1,1), x.reshape(-1,1)) KX = rbf_kernel(xp.reshape(-1,1), x.reshape(-1,1)) clf = Lasso(alpha=0.01, max_iter=10000) clf.fit(kx, y2) yp = clf.predict(KX) fig, ax = plt.subplots() plt.ylim(-3,6) ax.plot(xp, yp, color='purple', label="estimate curve") ax.scatter(x, y2, color='blue', label="sample(with noise)") ax.plot(t, y1, color='green', label="-x*sin(x)") ax.legend(bbox_to_anchor=(1.05, 1), loc='upper left', borderaxespad=0, fontsize=11) plt.show() print("coef: ", clf.coef_) coef: [-0. 0. 0. -0. -0.79703436 -0. -0. -0. 0. -0. -0. 3.35731837 0. -0. -0.77644607 0. -0. 0. -0. -0.19590705 0. -0. 0. -0. 0. 0. -0. -0. -0. 0. -0. 0. -0. -0. 0. 0.58052561 0.3688375 0. -0. 1.75380012]こちらも元の関数にだいぶ近似していますね。また、パラメータ(coef)もかなりの部分が0になっているのも確認できます。

Elasticnet

L1正則化とL2正則化はどちらも損失関数に正則化項を加えていますが、それぞれ独立に考えることができ、どちらをどれくらい採用するか決めることができ、これをElasticNetと呼びます。実際、scikit-learnの実装ではElasticNetのパラメータを変えたものをLassoとRidgeとして関数定義していました。

まとめ

線形回帰における基底関数は任意の関数を選ぶことができる。ガウシアンカーネル(に限らない)は、自由度が高く過学習しがちなのでL1正則化やL2正則化によって制限を加えることで、より汎化性能の高い回帰モデルを作ることができる。

数回にわたって回帰シリーズについてまとめてみたが、scikit-learnのチートシートにおけるRegressionの内容はだいたい理解できるようになったのではないだろうか。

割と適当にまとめたので、ツッコミは歓迎します。

- 投稿日:2020-02-25T22:27:48+09:00

QiskitとBlueqatを比較してみた(初心者)

QiskitとBlueqatを比較してみた(初心者)

現在量子コンピュータの学習をしているが、量子コンピュータ用Pythonライブラリである「Qiskit」、「Blueqat」について初心者目線で比較してみた。かなり私見が入っているので、参考程度に読んでください。ちなみに、QiskitはIBM社製、BlueqatはMDR社製となっています。

評価ポイント

今回は以下の評価ポイントで比較してみる。

- 説明が充実しているか

- 実行環境の準備、利用のしやすさ

- 使用感(かなり私見)

今回はこれで評価しますが、何か他にいい評価基準があれば教えてください。

1. 説明が充実しているか

結論から言うと、説明は「Blueqat」の方が分かりやすい。以下にQiskitとBlueqatのAPIドキュメント、チュートリアルのリンクを載せておく。

・Qiskitチュートリアル

・Qiskit APIドキュメント

・Blueqatチュートリアル(英語)

・Blueqatチュートリアル(日本語)

・Blueqat APIドキュメントリンク先を見ていただけると分かるんですが、Qiskitの方はドキュメント体系が分かりにくい。なんか色々な人がパーツを作って合体させた感じがします。あと、地味に大きいのがBlueqatは日本企業ということもあり、チュートリアルが日本語に対応している。

2. 実行環境の準備、利用のしやすさ

実行環境の準備/利用のしやすさで言うと、私の目線では両者さほど変わらない。

まず、「実行環境の準備」についてだが、Pythonを利用する場合は両者「pip」コマンドでライブラリを準備するだけである。ただし、Qiskitは「IBM Q Experience」でインターネット経由でjupyter notebook環境を取り扱うことができます。ただし、Googleが提供している「Google Colaboratory」でも同様の環境が提供されているため、大きなアドバンテージにならないなと感じました。あとちょっと説明が脇道にそれますが、IBMが提供しているIBM Q ExperienceのCircuit Composerを利用するとドラック&ドロップで量子回路を作成することができます。気軽に試してみたいという方にはいいかもしれません。

3. 使用感(かなり私見)

使用感については、今後使っていく上で気づいた所があれば適宜追記/修正してきます。

正直な所「1. 説明が充実しているか」に引きずられる部分が大きい部分が大きく、やりたいことを比較的すぐ実行できるのはBlueqatであり、使用しずらさを感じる場面は今の所ないです。

ただし、Qiskitは計算結果を図で表示するまで簡単に実装できるので、jupyter notebookが視覚的に分かりやすくなる所が利点だと思います。今の所実装速度を求めるならBlueqat、視覚的に分かりやすいものを簡単に実装したいならQiskitって感じかなと考えています。総合評価

ということで、今までの評価を踏まえ総合評価は以下の通りとしました!

Qiskit Blueqat 説明が充実度 △ 〇 実行環境/利用のしやすさ 〇 〇 使用感 〇 〇 総合評価 △ 〇 異論は認めます!なぜなら使用感の評価がガバガバだからです(`・ω・´)

それではまた次の投稿で!

- 投稿日:2020-02-25T22:26:28+09:00

【他プログラミング言語修得者向け】Python 要点キャッチアップ10点

Overvierw

Pythonは、シンプルで習得がしやすいオブジェクト指向言語として有名である。

他言語修得者向けに、Python独自の要素を10点独断で選別したので、それを記載する。1. 改行の ";" が不要

多くの言語の共通ルールである「改行時は;」について、Pythonでは不要。

とはいえ、改行として認識自体はされるため、以下の様なコードを実行してもエラーにはならず、従来通りの挙動をする。>>> print("1"); print("2") 1 22. インデントがブロックを表す

他言語において、インデントはコードの可読性を高めるための要素で、挙動に影響はしなかった。

しかし、Pythonではインデントを使ってブロックを表現する。if x > 0: print("positive") # if文内 print("always") # if文外上記のコードでは、xが0以上の場合は"positive","always"の両方を表示、それ以外の場合でも"always"を出力する。

また、 以下の様に適切なインデントがない場合は

IndentationError: expected an indented blockが発生する。if x > 0: print("positive") # IndentationError発生3. シングルクォーテーション、ダブルクォーテーションが同義

Pythonにおいては、これらの間に違いは存在しない。以下のコードは、いずれも同様に挙動となる。

>>> print('single') single >>> print("double") double仮に文字列中に

'を入れる場合は、表記は異なる。>>> print('It\'s single') # \ でエスケープ It's single >>> print("It's double") # 文字列に含まれるクォーテーション It's double同じコード内で表記を統一する必要もないので、単語の場合はシングル、文章の場合はダブルなど、一定ルールを設けることも可能。

s = 'single' w = "It's a double!4. 変数宣言と型

varや型指定は不要。変数名 = 値の書式で 数値、文字列、真偽値 を格納できる。

ただし、値から型を推測するため、初期値が必要となる。

以下の表記は全てエラー。# 型指定は不要 int a = 1 ^ SyntaxError: invalid syntax # var の記述も不要 var a = 1 ^ SyntaxError: invalid syntax # 初期値がない場合もエラー a NameError: name 'a' is not definedまた、一度宣言した変数に、全く違う型の値を代入することができる。その場合、変数の型も同時に変わる。

>>> a = 100 >>> type(a) <class 'int'> >>> a = "text" >>> type(a) <class 'str'> >>> a = True >>> type(a) <class 'bool'>5. その他よく使うデータ型

Pythonでは数値、文字列、真偽値に加えて、 リスト、タプル、セット、辞書型 がある。

いずれも複数データを格納するデータ型で、特徴は以下の通り。

データ型名 特徴 宣言の仕方 リスト(list) 追加・重複の制限なし [val1, val2, ...] タプル(tuple) 宣言後の追加・更新を許可しない, パフォーマンスが高い (val1, val2, ...) セット(set) 同値の重複を許可しない {val1, val2, ...} 辞書型(dict) key-value 形式 {key1: val1, key2: val2, ...} ### リスト型 list1 = [1,2,3] type(list1) # -> <class 'list'> print(list1) # -> [1, 2, 3] print(list1[0] # -> 0 list1.append(4) print(list1) # -> [1, 2, 3, 4] ### セット型 set1 = {1,2,3,3} type(set1) # -> <class 'set'> print(set1) # -> {1, 2, 3} set1[0] = 9 # -> TypeError: 'set' object does not support item assignment set1.add(4) print(set1) # -> {1, 2, 3, 4} ### タプル型 tuple1 = (1,2,3) type(tuple1) # -> <class 'tuple'> print(tuple1) # -> (1,2,3,3) tuple1[0] = 9 # -> TypeError: 'tuple' object does not support item assignment ### 辞書型 dict1 = {"a": 123, "b": 456, "c": 789} type(dict1) # -> <class 'dict'> print(dict1) # -> {'a': 123, 'b': 456, 'c': 789} dict1["d"] = 0 print(dict1) # -> {'a': 123, 'b': 456, 'c': 789, 'd': 0}タプルの用途としては、統計値などの一度宣言した値や順番を変更したくないとき、または変更する必要がないときに利用する。

メモリを圧迫しないため、パフォーマンス向上につながる。また、これらは相互に変換することも可能。ただし、構成によってはエラーになる。

list1 = [1,2,3] print(tuple(list1)) # -> (1, 2, 3) print(set(list1)) # -> {1, 2, 3} list2 = [["a", 123], ["b", 456], ["c", 789]] print(dict(list2)) # -> {'a': 123, 'b': 456, 'c': 789}6. スライス操作

先のデータ型もそうだが、他言語では「配列」と呼ばれる様な複数要素をまとめて1つの変数で扱えるデータ型を、Pythonでは シーケンス型 と呼ぶ。

具体的には以下が該当。

型 解釈 文字列(string) 連続した文字 レンジ(range) 連続した数値 バイト(bytes) 連続したバイト リスト(list) 連続したデータ, あらゆるデータを扱える タプル(tuple) 要素追加・更新のできない連続したデータ セット(set) 重複を許可しない連続したデータ これらに対して、一部分を切り取ってコピーを返すスライス操作がPythonでは利用できる。

指定の際はseq[start:stop:step]の様に指定する。値を指定しなかった場合はデフォルト値が適用されるが、全て未指定にはできない。

引数 指定する値 デフォルト start 切り取り視点インデックス 0 end 切り取り終点インデックス 要素数に等しい値 step 切り取る際のステップ数

負数の場合は逆順にする1 インデックスは、 Pythonチュートリアル の考え方がわかりやすい。

つまり、「インデックスは要素と要素の境界を指し、最初の要素の左端が0」ということである。

また、マイナス指定インデックスは一番最後の文字を指すインデックスが-1, 以降前に戻る度に負の値が増加する。+---+---+---+---+---+---+ | P | y | t | h | o | n | +---+---+---+---+---+---+ 0 1 2 3 4 5 6 -6 -5 -4 -3 -2 -1上記を踏まえて、以下の様に利用する。

str = "Python" print(str[3:]) # -> "hon" print(str[:3] ) # -> "Pyt" print(str[::-1]) # -> "nohtyP" print(str[::2]) # -> "Pto"6. 制御文全般の留意点

全体的な留意点は以下。

- 条件式で

()は不要- 末尾に

:を記入する例えば、if 文の使い方は以下。他言語と比べて大きな違いはないが、

elifの表記だけやや特殊かも。### if文 if x > 0: print("positive") elif x < 0: print("negative") else: print("zero")7. for文はシーケンスと組み合わせて柔軟に回せる

in 以下で、先に述べたシーケンス型を指定することでその要素を回すことができる。

list1 = [1,2,3] for val in list1: print(val) 1 2 3シーケンス型の変数を事前に使っていない場合は、range関数で連続した数字のシーケンスを生成できるので便利。

# 引数1つの場合は0始まり for i in range(3): print(i) 0 1 2 # 引数2つの場合は始点を変更できる for i in range(1, 4): print(i) 1 2 3 # 引数3つの場合は間隔を変更できる for i in range(1, 8, 2): print(i) 1 3 5 78. 終了を伴う処理をwith文で簡易化できる

Python の特徴的な構文に、with が存在する。

一般的に他言語で「ファイルの読み書き」や「通信処理」を行う場合は、開始と終了を明確に宣言する必要があった。

しかし、Pythonではwith文と同時に開始処理を宣言することで、インデントを抜けた際に自動で終了処理を行ってくれる。ここでは、ファイルの読み書きを例としてみる。

# ファイルの読み込み with open("read.txt", "r") as file1: print(file1.read()) # ファイルの書き込み with open("write.txt", "w") as file2: print(file2.write())もちろん、以下の様に入れ子で宣言することも可能。

# ファイルから読み込んだ内容を別ファイルに書き込む with open("reaad.txt", "r") as file1: with open("write.txt", "w") as file2: file2.write(file1.read())9. 複数の値を返す関数を作成できる

まず、python における関数定義は以下の様に

defを使って行う。def double(x): return x * x print(double(10)) # -> 100この際に、返り値をタプル、またはカンマ区切りで複数指定することができる。カンマ区切りが可能なのは、Python においてカンマで区切られた値は丸括弧を省略したタプルとみなされるため。

このとき、この複数の返り値を異なる変数に格納することも可能。def test(): return "a", 123, True # return ("a", 123, True) と同義 print(test()) # -> ('a', 123, True) a, b, c = test() print(a) # -> 'a' print(b) # -> 123 print(c) # -> True10. ライブラリの利用はimport

Python は、 デフォルトで利用できる組み込み関数に加えて、適宜

importを実行することで各種ライブラリを簡単に利用することができる。

import宣言はプログラムの冒頭で宣言し、以下の順番で記述することがPEP8では望ましいとされている。

1. 標準ライブラリ

2. サードパーティライブラリ

3. ローカルライブラリ(自作のライブラリ)

グループ間は空白行で区切り、同一グループ内はアルファベット順とすることが多い。# 標準ライブラリ import math import os import sys # サードパーティライブラリ import Requests # 自作ライブラリ import my_package1 import my_package2また、

importと一緒にas,fromもよく使われる。

as を使うことで、importしたモジュールやオブジェクトに対して別名をつけることができる。

例えばmath を m, numpy を np とするのはよくある。import math as m import numpy as np print(np,array([1,2], [100,200])) # -> array([[1, 2],[100, 200]]) print(m.pi) # -> 3.141592653589793fromは、大別して以下2種類のいずれかの用法となる。

-from <モジュール名> import <オブジェクト名>

-from <パッケージ名> import <モジュール名>

ここで、ライブラリの階層は パッケージ > モジュール > オブジェクト の構造となっていることを踏まえると、上位階層から下位階層を取得するイメージとなる。めちゃくちゃざっくり言うと、

* パッケージ = ディレクトリ

* モジュール = クラスファイル

* オブジェクト = 各種関数、定数

と置き換えて認識してもよい。例えば、円周率πをよく使うなら、オブジェクトpiを指定してimportするとよい。

from math import pi # math クラスの pi オブジェクトをインポート print(pi) # math 指定なしに、そのまま利用できる。終わりに

10項目もあると結構な量になるが、ここにある内容を理解できればまずはPython初心者卒業といったところだろうか。

あとは各種汎用ライブラリ独自の用法を適宜把握できれば、コーディングはスイスイできるはず!

- 投稿日:2020-02-25T22:21:37+09:00

Pythonでコマンドライン引数の受け取り方

コマンドライン引数とは

コマンドライン引数とは、コンピュータのコマンド入力画面(コマンドライン)からプログラムを起動する際に指定する文字列のこと。また、これをプログラム側で受け取った変数などの値。

コマンドライン引数とはmain 関数の引数のことです。 実行するときに、 コマンドラインからコマンドライン引数に値を与えることができます。

http://www.ritsumei.ac.jp/~mmr14135/johoWeb/cmnds.html

>>> ls -a ↑ココPythonでコマンドライン引数を受け取る

Pythonでコマンドライン引数を受け取るには主に3つの方法があります。

sys.argvを使うargparseを使うclickを使うです。

sys.argv

最も認知されている(と思う)方法です。Pythonの標準ライブラリのsysを使用し取得します。

args.pyimport sys def main() -> None: args = sys.argv print(args) if __name__=='__main__': main()実行

>>> python args.py aaa 123 hoge ['args.py', 'aaa', '123', 'hoge']

メリット デメリット 簡単に記述できる どんな型が来るのかがわからない Python標準ライブラリである helpがない argparse

コマンドライン引数専用のPython標準ライブラリ。

Help機能や型の指定などができる。扱いはクセがある。args2.pyimport argparse def main() -> None: parser = argparse.ArgumentParser(description='説明') parser.add_argument('description', help='引数の説明') # 実行時指定しないとエラーになる。 parser.add_argument('hoge', help='hogehoge') # 順番が決まっている。 parser.add_argument('--foo', help='option') # ハイフンを1~2個つけると実行時指定しなくても良くなる。 args = parser.parse_args() print(args.description) print(args.hoge) print(args.foo) if __name__ == "__main__": main()実行

>>> python args2.py -h usage: aaa.py [-h] [--foo FOO] description hoge 説明 positional arguments: description 引数の説明 hoge hogehoge optional arguments: -h, --help show this help message and exit --foo FOO option >>> python args2.py aaa bbb aaa bbb None >>> python args2.py aaa bbb --foo 123 aaa bbb 123

メリット デメリット 機能が豊富 複雑 Helpがある Python標準ライブラリである click

Pythonのコマンドラインパーサ。別の言い方で、コマンドライン解析用モジュール。

Python標準ライブラリではないため別途インストールが必要だが、わかりやすさと使いやすさで上記2つを抜いている。そのため、これさえおぼえておけばOK

ちなみに、click、Flask、jinjaは同じプロジェクト。# インストール pip install clickargs3.pyimport click @click.command() @click.option('--args', prompt=True, help='説明') @click.option('--hoge', prompt=True, is_flag=True, help='hogehoge') def main(args: str, hoge: bool) -> None: if hoge: print(args) if __name__ == "__main__": main()実行

>>> python args3.py --args foo --hoge foo >>> python args3.py Args: aaaaa Hoge [y/N]: y aaaaa

メリット デメリット 機能が豊富 Python標準ライブラリではない 使いやすい プロンプトに表示できる 進捗バーも表示できる パスワード入力を隠すことができる 複数入力もできる 参考資料

Pythonでコマンドライン引数を扱う方法(sys.argv, argparse)

Pythonでコマンドライン引数を渡す方法

ArgumentParserの使い方を簡単にまとめた

Python: コマンドラインパーサの Click が便利すぎた

- 投稿日:2020-02-25T22:12:19+09:00

S3上ObjectのKeyを普通のdate形式からHive形式に変更する

何を書いた記事か

ぼく「とりあえずアプリのログとか分析用データとかS3に吐き出しとこう!パス?後から考えればいいからとりあえず

yyyy-mm-ddとかで切っておけばいいよ!」〜1年後〜

ぼく「なんでこんな分析かけづらいパス形式でデータが保管されてるんや・・」

という状態になってたのでなんとかしようという話です。何が嬉しいのか

上の例のように、特に運用を考えずに下記のようなKeyでS3上に出力してしまっている場合

s3://BUCKET_NAME/path/to/2020-01-01/log.jsonいざ分析にかけようと思ったとき、ここにおいたファイルに対してAthenaなどでクエリを投げる時、日付に対して適切なPartitionが効かせられないという状況に陥ります。

どういうことかというと、

「2019年1月のデータを横断的に分析しよう!」

と思っても、S3では2019−01-01のような文字列がKeyになっているだけで、2019-01-*のようなクエリをかけることは至難の技です。そこで、S3への保管の仕方をHive形式に変換することを考えます。Hive形式とは下記のような形式です。

s3://BUCKET_NAME/path/to/year=2020/month=01/date=01/log.jsonこのようなKeyでObjectを保管しておいて、Athenaのテーブル上でyyyy/mm/ddに対してPartitionを切ってあげると、SQLのWhere句で特定日付に区切ってクエリを実行することができるようになり、分析もしやすくなります。

ただ、S3はKey-Value形式でObjectを保管する形式のストレージなので、Objectに対するKeyをライトに一括変更することができません。

そこで、指定した期間のObjectに対して一括でKeyをHive形式に変更するスクリプトを作成し、Lambdaから実行しました。作成したLambda関数

早速ですが、作成したLambdaは下記のようなシンプル1ファイルスクリプトです。

import os import boto3 from datetime import datetime, timedelta # Load Environment Variables S3_BUCKET_NAME = os.environ['S3_BUCKET_NAME'] S3_BEFORE_KEY = os.environ['S3_BEFORE_KEY'] S3_AFTER_KEY = os.environ['S3_AFTER_KEY'] S3_BEFORE_FORMAT = os.environ['S3_BEFORE_FORMAT'] FROM_DATE = os.environ['FROM_DATE'] TO_DATE = os.environ['TO_DATE'] DELETE_FRAG = os.environ['DELETE_FRAG'] def date_range(from_date: datetime, to_date: datetime): """ Create Generator Range of Date Args: from_date (datetime) : datetime param of start date to_date (datetime) : datetime param of end date Returns: Generator """ diff = (to_date - from_date).days + 1 return (from_date + timedelta(i) for i in range(diff)) def pre_format_key(): """ Reformat S3 Key Parameter given Args: None Returns: None """ global S3_BEFORE_KEY global S3_AFTER_KEY if S3_BEFORE_KEY[-1] == '/': S3_BEFORE_KEY = S3_BEFORE_KEY[:-1] if S3_AFTER_KEY[-1] == '/': S3_AFTER_KEY = S3_AFTER_KEY[:-1] def change_s3_key(date: datetime): """ Change S3 key from datetime format to Hive format at specific date Args: date (datetime) : target date to change key Returns: None """ before_date_str = datetime.strftime(date, S3_BEFORE_FORMAT) print('Change following date key format : {}'.format(before_date_str)) before_path = f'{S3_BEFORE_KEY}/{before_date_str}/' after_path = "{}/year={}/month={}/date={}".format( S3_AFTER_KEY, date.strftime('%Y'), date.strftime('%m'), date.strftime('%d') ) s3 = boto3.client('s3') response = s3.list_objects_v2( Bucket=S3_BUCKET_NAME, Delimiter="/", Prefix=before_path ) try: for content in response["Contents"]: key = content['Key'] file_name = key.split('/')[-1] after_key = f'{after_path}/{file_name}' s3.copy_object( Bucket=S3_BUCKET_NAME, CopySource={'Bucket': S3_BUCKET_NAME, 'Key': key}, Key=after_key ) if DELETE_FRAG == 'True': s3.delete_object(Bucket=S3_BUCKET_NAME, Key=key) except Exception as e: print(e) return def lambda_handler(event, context): pre_format_key() from_date = datetime.strptime(FROM_DATE, "%Y%m%d") to_date = datetime.strptime(TO_DATE, "%Y%m%d") for date in date_range(from_date, to_date): change_s3_key(date)実行時には下記の設定をLambdaで入れてあげる必要があります。

- 環境変数に下記を設定

環境変数 値 備考 S3_BUCKET_NAME S3バケット名 S3_BEFORE_KEY 変更前S3キー(path/to) S3_AFTER_KEY 変更前S3キー(path/to) キーの移動が不要であれば上と同じ値 S3_BEFORE_FORMAT 変更前日付フォーマット %Y-%m-%dなど、Pythonのdatetimeが認識できる形式FROM_DATE 開始日(yyyymmdd) キー変更を行いたいObjectの始点 TO_DATE 終了日(yyyymmdd) キー変更を行いたいObjectの終点 DELETE_FRAG True/False 元のObjectを削除するかどうか

- Lambdaの実行RoleにS3の対象バケットの操作権限を付与

- 実行時間や割り当てメモリは適宜調整

必要な設定は環境変数化したので、自分の環境に合わせて好きに設定していただければと思います。

また、エラーハンドリングは面倒で実装していません。

一度だけSPOTで実行するスクリプトなので最小限の実装に止めています。気になる方は修正してください。結果

既存のS3 Keyに対して通常のdate形式からHive形式に変更し、無事に分析しやすい形式にすることができました。

追加情報ですが、path/to/のレイヤーでGlue Cralwerを実行すると、Athenaで読み込めるData CatalogがPartition含めて自動的に生成されるので、よりAthenaでの分析ライフが充実したものとなります。

ここの実装がおかしいとか、もっとこうした方がいいとかあれば教えてください!

大した内容ではありませんが、リポジトリも公開しておきます。

https://github.com/kzk-maeda/change-s3-key/blob/master/lambda_function.py

- 投稿日:2020-02-25T22:08:17+09:00

SEIRモデルでコロナウイルスの挙動を予測してみた。

1.はじめに

2019年12月に中国の湖北省の武漢で発生した新型コロナ肺炎(Covid-19)が、日本にも感染者数が増加しています。インフルエンザ, AIDS, SARS,などの感染病がどのプロセスで人間集団の中で拡大していくことを理解することは、予防接種の設定、感染者の隔離などの保健政策の効果を確認するためにも重要であります。

前回の記事では、SIRモデルを説明しましたが、感染病の潜伏期間を考慮したSEIRモデルを紹介します。

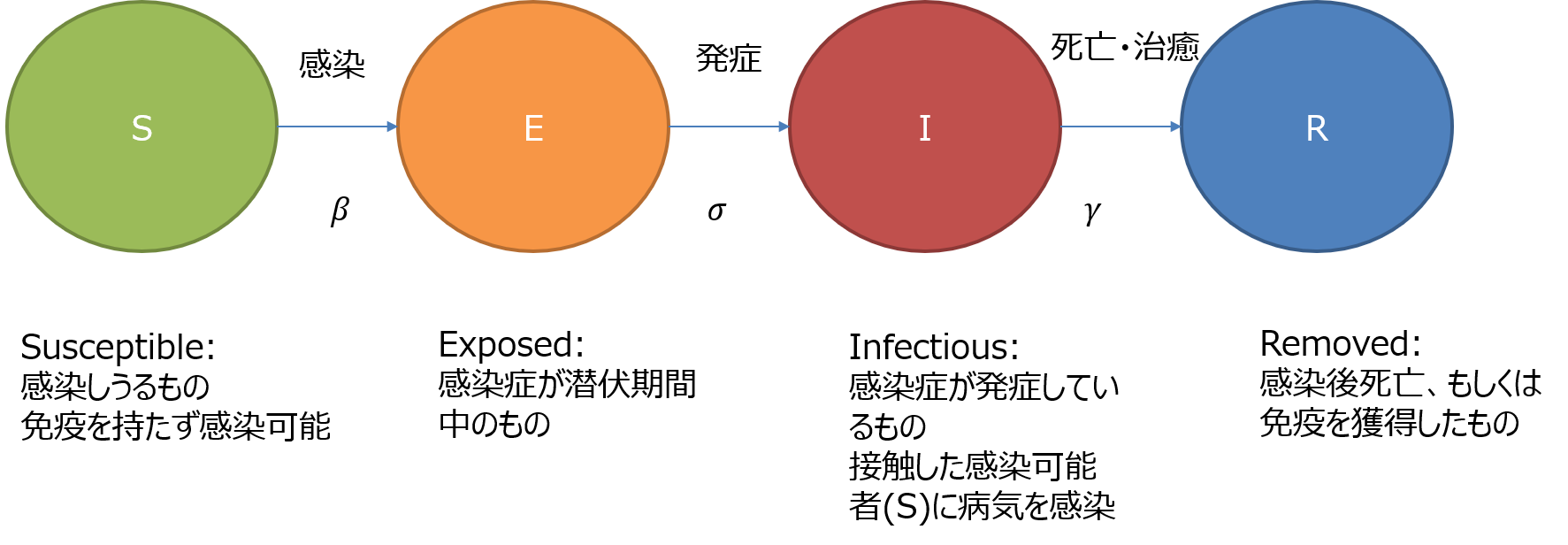

このモデルをPythonで計算する過程と、このSEIRモデルを利用しコロナウイルスがどう拡散するか計算結果を紹介します。2.伝染病の予測モデル(SEIRモデル)

SEIRモデルでは、全体人口を次の集団に分類し、時間に関する各集団の人口増減を微分方程式で表す。

- S(Susceptible) : 伝染病に対する免疫がない。感染可能者

- E(Exposed):感染症が潜伏期間中の者

- I(Infectious):感染により発病し、感染可能者(S)への伝染可能な者。感染者

- R (Removed) : 発病から回復し、免疫を獲得したもの。あるいは発病から回復できず死亡した者。(このモデルのシステムから排除されるため、Removedと言う。)

各集団の人口増減を次の微分方程式で表す。

\begin{align} \frac{dS}{dt} &= -\beta \frac{SI}{N} \\ \frac{dE}{dt} &= \beta \frac{SI}{N} -\sigma E \\ \frac{dI}{dt} &= \sigma E -\gamma I \\ \frac{dR}{dt} &= \gamma I \\ \end{align}\begin{align} S &: 感染しうるもの、免疫を持たず感染可能 \quad \text{(Susceptible)} \\ E &: 感染症が潜伏期間中のもの \quad \text{(Infectious)} \\ I &: 感染症が発症しているもの、接触した感染しうるもの(S)に病気を感染 \quad \text{(Infectious)} \\ R &: 感染後死亡者、もしくは免疫を獲得した者 \quad \text{(Removed)} \\ N &: 全人口, S+E+I+R \end{align}\begin{align} \beta &: 感染率\quad \text{(The infectious rate)} \\ \sigma &: 暴露後に感染症を得る率\quad \text{(The rate at which an exposed person becomes infective)} \quad [1/day] \\ \gamma &:除去率\quad \text{(The Recovery rate)} \quad [1/day] \\ \end{align}\begin{align} \ l_p &: 感染待ち時間 \text{(latency period [day])}\quad \sigma= \frac{1}{l_p} \\ \ i_p &: 感染期間 \text{(Infectious period [day])}\quad \sigma= \frac{1}{i_p} \\ \end{align}このSIRモデルの前提条件

- 一度免疫を獲得した者は2度と感染することなく、免疫を失うこともありません。

- 全体人口で外部からの流入及び流出はありません。なお出生者及び感染以外の原因で死亡する者もいません。3.SEIRモデルの計算

SIRモデルは、数値積分を用いて解きます。ここでは、PythonのScipyモジュールのRunge-Kutta方程式を解くodeint関数を利用します。

import numpy as np from scipy.integrate import odeint import matplotlib.pyplot as plt次に、SIRモデルの微分方程式をodeintで計算できる形に記述します。ここで、v[0], v[1], v[2],v[3]がそれぞれS,E,I,Rに対応します。

# Define differential equation of SEIR model ''' dS/dt = -beta * S * I / N dE/dt = beta* S * I / N - epsilon * E dI/dt = epsilon * E - gamma * I dR/dt = gamma * I [v[0], v[1], v[2], v[3]]=[S, E, I, R] dv[0]/dt = -beta * v[0] * v[2] / N dv[1]/dt = beta * v[0] * v[2] / N - epsilon * v[1] dv[2]/dt = epsilon * v[1] - gamma * v[2] dv[3]/dt = gamma * v[2] ''' def SEIR_EQ(v, t, beta, epsilon, gamma, N ): return [-beta * v[0] * v[2] / N ,beta * v[0] * v[2] / N - epsilon * v[1], epsilon * v[1] - gamma * v[2],gamma * v[2]]そして、数値積分に必要な各パラメータ及び初期条件を定義します。ここでは、人口1,000名の集団に対し、初期の感染症が潜伏期間中の者が1名がいると仮定します。

感染率を1に、感染待ち時間を2日、感染期間を7.4日と設定します。# parameters t_max = 100 #days dt = 0.01 # initial_state S_0 = 99 E_0 = 1 I_0 = 0 R_0 = 0 N_pop = S_0 + E_0 + I_0 + R_0 ini_state = [S_0, E_0, I_0, R_0] # [S[0],E,[0], I[0], R[0]] #感染率 beta_const = 1 #感染率 #暴露後に感染症を得る率 latency_period = 2 #days epsilon_const = 1/latency_period #回復率や隔離率 infectious_period = 7.4 #days gamma_const = 1/infectious_period数値積分結果をresultに格納し、この結果を時間軸に対しプロットします。

# numerical integration times = np.arange(0, t_max, dt) args = (beta_const, epsilon_const, gamma_const, N_pop) # Numerical Solution using scipy.integrate # Solver SEIR model result = odeint(SEIR_EQ, ini_state, times, args) # plot plt.plot(times, result) plt.legend(['Susceptible', 'Exposed', 'Infectious', 'Removed']) plt.title("SEIR model COVID-19") plt.xlabel('time(days)') plt.ylabel('population') plt.grid() plt.show()このグラフから言えることは、100名の集団に感染症が潜伏期間中の者が1名(Exposed(0))発生することで、最終的に100名(Removed(100))が感染を経験することである。そして、感染者(Infectious)のピークは約18日辺りで発生し、その後は感染が収束することがわかる。

このように感染病に関するパラメータをもって、感染病が人口集団に及ぼす影響を評価することが可能である。4.コロナウイルスの予測

現在、コロナウイルスの発症事例より、SEIRのパラメータを推定する研究論文が多数発表されています。今回は、2月16日に発表された論文に掲載されたパラメータ推定値で、SEIRモデルを計算してみます。(参考文献 2)

Parameter 中国本土(湖北省除く) 湖北省(武漢除く) 武漢 人口数 N (million) 1340 45 14 感染率 [beta] 1.0 1.0 1.0 Latency period (days) 2 2 2 infectious_period (days) 6.6 7.2 7.4 E_0 696 592 318 I_0 652 515 389 計算結果を示します。それぞれ縦軸の人口の数値が異なることに注意してください。

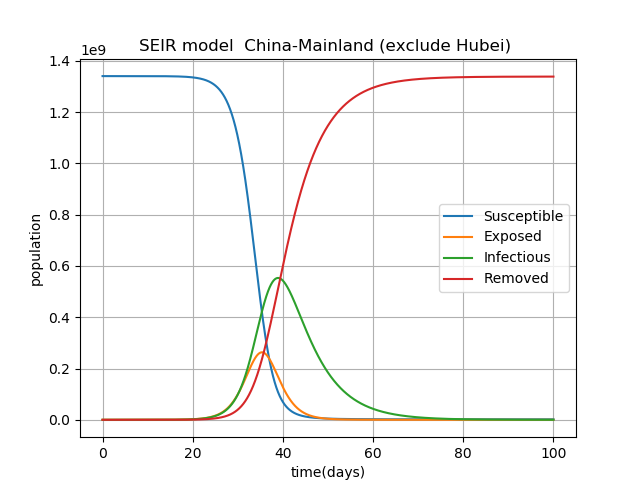

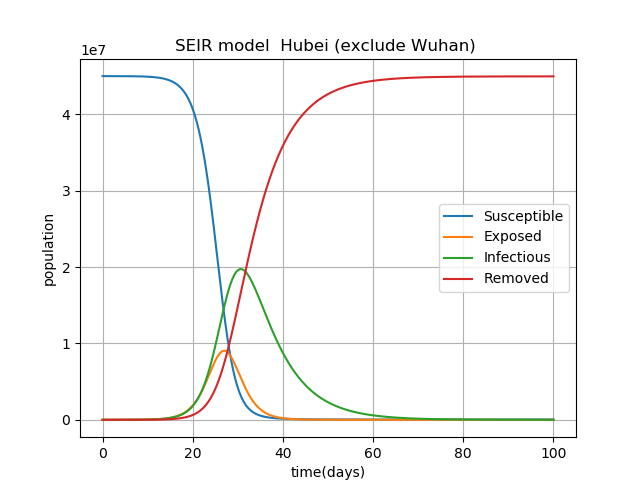

1番目のグラフは、湖北省を除く中国本土の感染拡大の予測です。

このパラメータでの予測だと、30日~40日で感染者数はピークを迎えて、最終的にはほぼ100%の人口が感染を経験する(Removed(100))ことになります。正直、驚きました。

恐らくWorst Caseを想定した予測結果になったと思います。今回のコロナウイルスには各段に注意が必要だと思います。5. 参考文献

SEIR and SEIR models https://institutefordiseasemodeling.github.io/Documentation/general/model-seir.html

Epidemic analysis of COVID-19 in China by dynamical modeling https://arxiv.org/abs/2002.06563

- 投稿日:2020-02-25T22:08:17+09:00

感染病の数学予測モデルの紹介: (コロナウイルス、SEIRモデル)

1.はじめに

2019年12月に中国の湖北省の武漢で発生した新型コロナ肺炎(Covid-19)が、日本にも感染者数が増加しています。インフルエンザ, AIDS, SARS,などの感染病がどのプロセスで人間集団の中で拡大していくことを理解することは、予防接種の設定、感染者の隔離などの保健政策の効果を確認するためにも重要であります。

前回の記事では、SIRモデルを説明しましたが、感染病の潜伏期間を考慮したSEIRモデルを紹介します。

このモデルをPythonで計算する過程と、このSEIRモデルを利用しコロナウイルスがどう拡散するか計算結果を紹介します。2.伝染病の予測モデル(SEIRモデル)

SEIRモデルでは、全体人口を次の集団に分類し、時間に関する各集団の人口増減を微分方程式で表す。

- S(Susceptible) : 伝染病に対する免疫がない。感染可能者

- E(Exposed):感染症が潜伏期間中の者

- I(Infectious):感染により発病し、感染可能者(S)への伝染可能な者。感染者

- R (Removed) : 発病から回復し、免疫を獲得したもの。あるいは発病から回復できず死亡した者。(このモデルのシステムから排除されるため、Removedと言う。)

各集団の人口増減を次の微分方程式で表す。

\begin{align} \frac{dS}{dt} &= -\beta \frac{SI}{N} \\ \frac{dE}{dt} &= \beta \frac{SI}{N} -\sigma E \\ \frac{dI}{dt} &= \sigma E -\gamma I \\ \frac{dR}{dt} &= \gamma I \\ \end{align}\begin{align} S &: 感染しうるもの、免疫を持たず感染可能 \quad \text{(Susceptible)} \\ E &: 感染症が潜伏期間中のもの \quad \text{(Infectious)} \\ I &: 感染症が発症しているもの、接触した感染しうるもの(S)に病気を感染 \quad \text{(Infectious)} \\ R &: 感染後死亡者、もしくは免疫を獲得した者 \quad \text{(Removed)} \\ N &: 全人口, S+E+I+R \end{align}\begin{align} \beta &: 感染率\quad \text{(The infectious rate)} \\ \sigma &: 暴露後に感染症を得る率\quad \text{(The rate at which an exposed person becomes infective)} \quad [1/day] \\ \gamma &:除去率\quad \text{(The Recovery rate)} \quad [1/day] \\ \end{align}\begin{align} \ l_p &: 感染待ち時間 \text{(latency period [day])}\quad \sigma= \frac{1}{l_p} \\ \ i_p &: 感染期間 \text{(Infectious period [day])}\quad \sigma= \frac{1}{i_p} \\ \end{align}このSIRモデルの前提条件

- 一度免疫を獲得した者は2度と感染することなく、免疫を失うこともありません。

- 全体人口で外部からの流入及び流出はありません。なお出生者及び感染以外の原因で死亡する者もいません。3.SEIRモデルの計算

SIRモデルは、数値積分を用いて解きます。ここでは、PythonのScipyモジュールのRunge-Kutta方程式を解くodeint関数を利用します。

import numpy as np from scipy.integrate import odeint import matplotlib.pyplot as plt次に、SIRモデルの微分方程式をodeintで計算できる形に記述します。ここで、v[0], v[1], v[2],v[3]がそれぞれS,E,I,Rに対応します。

# Define differential equation of SEIR model ''' dS/dt = -beta * S * I / N dE/dt = beta* S * I / N - epsilon * E dI/dt = epsilon * E - gamma * I dR/dt = gamma * I [v[0], v[1], v[2], v[3]]=[S, E, I, R] dv[0]/dt = -beta * v[0] * v[2] / N dv[1]/dt = beta * v[0] * v[2] / N - epsilon * v[1] dv[2]/dt = epsilon * v[1] - gamma * v[2] dv[3]/dt = gamma * v[2] ''' def SEIR_EQ(v, t, beta, epsilon, gamma, N ): return [-beta * v[0] * v[2] / N ,beta * v[0] * v[2] / N - epsilon * v[1], epsilon * v[1] - gamma * v[2],gamma * v[2]]そして、数値積分に必要な各パラメータ及び初期条件を定義します。ここでは、人口1,000名の集団に対し、初期の感染症が潜伏期間中の者が1名がいると仮定します。

感染率を1に、感染待ち時間を2日、感染期間を7.4日と設定します。# parameters t_max = 100 #days dt = 0.01 # initial_state S_0 = 99 E_0 = 1 I_0 = 0 R_0 = 0 N_pop = S_0 + E_0 + I_0 + R_0 ini_state = [S_0, E_0, I_0, R_0] # [S[0],E,[0], I[0], R[0]] #感染率 beta_const = 1 #感染率 #暴露後に感染症を得る率 latency_period = 2 #days epsilon_const = 1/latency_period #回復率や隔離率 infectious_period = 7.4 #days gamma_const = 1/infectious_period数値積分結果をresultに格納し、この結果を時間軸に対しプロットします。

# numerical integration times = np.arange(0, t_max, dt) args = (beta_const, epsilon_const, gamma_const, N_pop) # Numerical Solution using scipy.integrate # Solver SEIR model result = odeint(SEIR_EQ, ini_state, times, args) # plot plt.plot(times, result) plt.legend(['Susceptible', 'Exposed', 'Infectious', 'Removed']) plt.title("SEIR model COVID-19") plt.xlabel('time(days)') plt.ylabel('population') plt.grid() plt.show()このグラフから言えることは、100名の集団に感染症が潜伏期間中の者が1名(Exposed(0))発生することで、最終的に100名(Removed(100))が感染を経験することである。そして、感染者(Infectious)のピークは約18日辺りで発生し、その後は感染が収束することがわかる。

このように感染病に関するパラメータをもって、感染病が人口集団に及ぼす影響を評価することが可能である。4.コロナウイルスの予測

現在、コロナウイルスの発症事例より、SEIRのパラメータを推定する研究論文が多数発表されています。今回は、2月16日に発表された論文に掲載されたパラメータ推定値で、SEIRモデルを計算してみます。(参考文献 2)

Parameter 中国本土(湖北省除く) 湖北省(武漢除く) 武漢 人口数 N (million) 1340 45 14 感染率 [beta] 1.0 1.0 1.0 Latency period (days) 2 2 2 infectious_period (days) 6.6 7.2 7.4 E_0 696 592 318 I_0 652 515 389 計算結果を示します。それぞれ縦軸の人口の数値が異なることに注意してください。

1番目のグラフは、湖北省を除く中国本土の感染拡大の予測です。

このパラメータでの予測だと、30日~40日で感染者数はピークを迎えて、最終的にはほぼ100%の人口が感染を経験する(Removed(100))ことになります。正直、驚きました。

恐らくWorst Caseを想定した予測結果になったと思います。今回のコロナウイルスには各段に注意が必要だと思います。5. 参考文献

SEIR and SEIR models https://institutefordiseasemodeling.github.io/Documentation/general/model-seir.html

Epidemic analysis of COVID-19 in China by dynamical modeling https://arxiv.org/abs/2002.06563

- 投稿日:2020-02-25T21:37:32+09:00

【機械学習】線形重回帰をscikit-learnと数学の両方から理解する

1.目的

機械学習をやってみたいと思った場合、scikit-learn等を使えば誰でも比較的手軽に実装できるようになってきています。

但し、仕事で成果を出そうとしたり、より自分のレベルを上げていくためには

「背景はよくわからないけど何かこの結果になりました」の説明では明らかに弱いことが分かると思います。この記事では、2~3で「理論はいいからまずはscikit-learn使ってみる」こと、4以降で「その背景を数学から理解する」2つを目的としています。

※私は文系私立出身なので、数学に長けていません。可能な範囲で数学が苦手な方にもわかりやすいように説明するよう心がけました。

(とはいえ、今回は線形代数の知識が必要になるので、難しいと感じる方は、そういうものか、と受け流すくらいで大丈夫です。)※「数学から理解する」シリーズとして、同様の記事を投稿していますので、併せてお読みいただけますと幸いです。

【機械学習】線形単回帰をscikit-learnと数学の両方から理解する

【機械学習】ロジスティック回帰をscikit-learnと数学の両方から理解する

【機械学習】SVMをscikit-learnと数学の両方から理解する

【機械学習】相関係数はなぜ-1から1の範囲を取るのか、数学から理解する2. 線形(重)回帰とは

上記の、線形単回帰とも重複する箇所がありますので線形単回帰の記事も併せて参考にしてください。

【機械学習】線形単回帰をscikit-learnと数学の両方から理解する(1) 回帰とは

数値を予測すること。機械学習では、他に「分類」があるが、「●●円」「△Kg」といった数値を予測したい場合は、回帰を使うと考えればよい。

(2) 線形回帰とは

若干の語弊はあるかもしれないですが、

「求めたいもの($=y$)」と、「その求めたいものに影響を与えると思われるもの

($=x$)」に線形の関係がある場合、その線形の特徴を使って$y$を求めるやり方を線形回帰といいます。線形単回帰は$x$は1つでしたが、線形重回帰は$x$が複数あります。

分かりづらいと思うので、具体例を出します。

<具体例>

あなたは自営業でアイスクリーム屋さんを営んでおり、売上の目途を安定的に立てるため、「自分の店のアイスクリームの売上を予測できるようになりたい」と強く思っているとします。

あなたは、自分の店のアイスクリームの売上に影響を与えているのは何だろうかと必死に考えました。

線形単回帰の記事では、アイスクリームの売上に影響を与えているのは「気温」と仮定して話を進めてきましたが、よく考えると、あなたが本当にアイスクリーム屋さんを営んでいたとしたら、売上に影響を与えているのは本当に「気温だけ」という結論をたてるでしょうか。おそらく、気温だけでなく、その日のアイスクリーム屋さんの通りの交通量や、それこそ、一緒に働く従業員の影響も大きいと考えるのではないでしょうか。

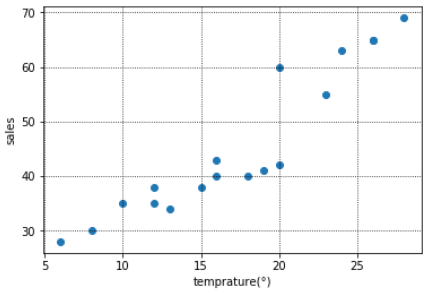

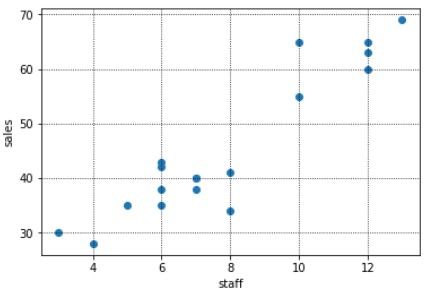

このように、通常は目的変数(アイスクリームの売上)に影響を与えると思われる説明変数は複数あり、場合によっては数万個ある、という場合もあります。そこで、下記のように「いくつかの説明変数($=x$)」と「目的変数(アイスクリームの売上($=y$))」を図示してみると、説明変数と目的変数(アイスクリームの売上)にはおおよそ直線の形(=$ax+b$)が引けそう(=線形である)なものや、あまり関係なさそうなものがあることがわかります。

このように図示すると、売上と線形の関係にありそうな「気温」と「従業員数」を説明変数に使用し、「交通量」は使わないという選択もできます。

ここでは、後の例として使うので、「交通量」も説明変数に入れていきます。次から、scikit-learnを使って気温・交通量・従業員数から、アイスクリームの売上を求める機械学習のモデルを構築してみましょう。

3.scikit-learnで線形回帰

(1)必要なライブラリのインポート

線形回帰を行うために必要な下記をインポートしておく。

import numpy as np import pandas as pd from sklearn.linear_model import LinearRegression(2)データの準備

気温、交通量、従業員数とアイスクリームの売上を下記のようにdataとして設定する。

※例えば、下記でいうと気温が8°の日は売上が30万円、10°の日は売上が35万円となる。data = pd.DataFrame({ "temprature":[8,10,6,15,12,16,20,13,24,26,12,18,19,16,20,23,26,28], "car":[100,20,30,15,60,25,40,20,18,30,60,10,8,25,35,90,25,55], "clerk":[3,5,4,6,6,7,12,8,12,10,7,7,8,6,6,10,12,13], "sales(=y)":[30,35,28,38,35,40,60,34,63,65,38,40,41,43,42,55,65,69] })(3)モデル構築

(ⅰ)データ整形

まずはモデル構築をするためにデータの形を整えていきます。

y = data["sales(=y)"].values X = data.drop("sales(=y)", axis=1).values #sales以外の列をXとして定義する、という意味今回はpython文法の記事ではないので詳細は割愛しますが、Xとyをscikit-learnで線形回帰するための形に整えます。

※このあたりもある程度しっかりわかっていないと書けないコードだと思うので、どこかでまとめたいと思っています。(ⅱ)モデル構築

いよいよ、モデル構築のコードです。

regr = LinearRegression(fit_intercept = True) regr.fit(X,y)単純なモデルであればこれで終わりです。

regrという変数にこれから線形回帰モデルを作ります!と宣言のようなことを行い、次の行で、そのregrに準備したXとyをフィット(=学習)させるというイメージです。(ⅲ)直線の傾きと切片を出してみる

「2. 線形(重)回帰とは」(2)で記載しましたが、先ほどまでのscikit-learnで$y=a_1x_1+ a_2x_2 + a_3x_3 + b$の$a$と$b$を求め、気温、交通量、従業員数から売上を予測する直線の式を裏で求めています。

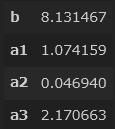

今のままだと実感がわかないので、実際に傾きと切片を出しておきましょう。b = regr.intercept_ a1 = regr.coef_[0] a2 = regr.coef_[1] a3 = regr.coef_[2] pd.DataFrame([b,a1,a2,a3],index = ["b","a1","a2","a3"])つまり、今回の線形回帰の式は、$y = 1.074159x_1 + 0.04694x_2 + 2.170663x_3 + 8.131467$で求められることが分かります。

補足になりますが、最初の図示で売上とあまり関係なさそうだった交通量($x_2$)の係数($=a_2$)は0.04694と、他2つの係数に比べて非常に小さいことが、計算からもわかりますね。つまり、交通量は$y$を求める際にあまり影響を与えない(=重要でない)変数であることが、あらためてわかります。

(6)現実世界では・・

モデルを作って終わり、では意味ないですね。現実世界では、この予測モデルを使って、今後の売上を予測していくことが必要です。

あなたは今後の3日分の気温、見込み交通量、従業員数をメモしました。

それを下記のようにzという変数に格納します。z = pd.DataFrame([[20,15,18], [15,60,30], [5,8,12]])やりたいのは、先ほどscikit-learnで求めた直線の式に、上記の今後のデータをあてはめ、売り上げを予測することです。

regr.predict(z)このようにすると、「([69.39068087, 92.18012508, 39.92573722])」と結果が表示されます。

つまり、明日の売上は約69.4万円、明後日は約92.2万円・・というかたちです。

むこう1か月分のデータが取得できれば、売上のおおよその目途が立つということになり、あなたの目標は達成されます。細かいことは他にも様々ありますが、まずはオーソドックスな線形回帰を実装してみるという点では良いのではないでしょうか。

4.線形(重)回帰を数学から理解する

さて、3まではscikit-learnを用いて$y=a_1x_1+ a_2x_2 + ・・・+ a_ix_i +b$の$a$と$b$を算出→今後3日間のデータから売上を予測するという流れを実装してみました。

ここでは、この流れの「$a$と$b$を算出」は、数学的にはどのように計算されているのかを明らかにしていきたいと思います。

※現状はこの知識は必要ないという方は読み飛ばしていただいて結構です。

※今回はベクトル、線形代数が登場してきますので、難しいと感じる方は、「そういうものなのだ」と思っていただく程度で大丈夫です。(1)前提知識(基本的なベクトル、線形代数)

$\frac{∂c}{∂\boldsymbol{x}} = 0 ←定数をxで微分すると0になる$

$\frac{∂(\boldsymbol{c}^T\boldsymbol{x})}{∂\boldsymbol{x}} = \boldsymbol{c}$

$\frac{∂(\boldsymbol{x}^TC\boldsymbol{x})}{∂\boldsymbol{x}} = (C

+ C^T)\boldsymbol{x}$(2)数学的な理解

(ⅰ)重回帰分析の式について

◆重回帰分析の式

前半でも触れましたが、重回帰分析の式は一般に下記のように表されます。$\hat{y} = a_1x_1 + a_2x_2 + ・・ + a_mx_m + a_0・1$

※$a_0・1$は、いわゆる$y = ax + b$でいう$b$のことを指していて、定数の何らかの数値として設定しています。

※今回は詳細は割愛しますが、$a_0・1$はデータ全体を標準化すれば0になります。今回は標準化はしないですが、通常は標準化することも多いので、$a_0・1$を解析的に求めることはしていません。◆今回の例で言うと・・

$x_1$が気温、$x_2$が交通量、$x_3$が従業員数で、それぞれの数値に何らかの係数$a_1,a_2,a_3$を掛けて、最後に定数$a_0・1$を足して売上$\hat{y}$を求めています。(ⅱ)重回帰分析の式をベクトルで表現する

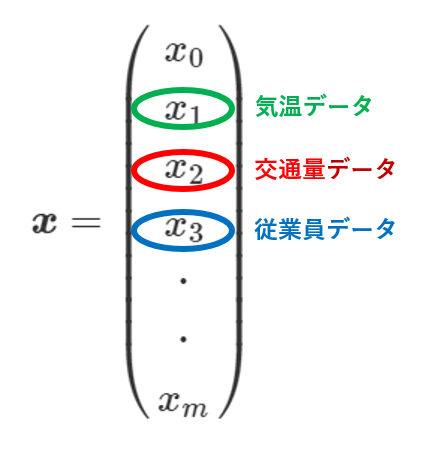

(ⅰ)の重回帰分析の式の$x$をベクトル$x$、すなわち$\boldsymbol{x}$として表すと下記のようになります。

今回は説明変数が3つなので$x_3$までになりますが、一般には上記のように表します。

そして、例えば上記の$x_1$の気温データも、データは1つではなく、その中には複数日程分の気温データが格納されているはずです。

それを行列$X$で表しているのが下記です。同様にベクトル$a$、すなわち$\boldsymbol{a}$は下記のように表せます。

$

\boldsymbol{a} = \begin{pmatrix}

a_0\\

a_1\\

a_2\\

a_3\\

・\\

・\\

a_m

\end{pmatrix}

$つまり、元の売上を予測する重回帰分析の式が$\hat{y} = a_1x_1 + a_2x_2 + ・・ + a_mx_m + a_0・1$なので、$\hat{y} = \boldsymbol{X}\boldsymbol{a}$と表すことができます。

重要なことは、$\hat{y}$と$\boldsymbol{X}$は自分の手元にあるデータからわかるので、これらを代入して$\boldsymbol{a}$、すなわち重回帰分析の式の各説明変数の係数が計算できるということです。

次から、この式を用いて$\boldsymbol{a}$を解析的(=手計算)に求めていきましょう。

Scikit-learnが裏で行っているのも、これと同じ計算です。(厳密には異なるのですが、後程触れます。)(ⅲ)誤差関数の計算

線形単回帰の記事でも触れていますが、$\hat{y} = a_1x_1 + a_2x_2 + ・・ + a_mx_m + a_0・1$の$a_1$や$a_2$、$a_3$を決めるには、本当の売上$y$と、あくまで予測値の$\hat{y}$の差がなるべく小さくなるように、良さげな$a_1,a_2,a_3$を設定します。

「良さげな」とはどういうことか、$y$と$\hat{y}$の差(誤差関数)を計算しながら見ていきましょう。

$\begin{align}

E &=

\sum_{i=1}^n ({y_i - \hat{y}})^{2}\\

&= (y - \hat{y})^T(y - \hat{y})\\

&= (y - \boldsymbol{X}\boldsymbol{a})^T(y - \boldsymbol{X}\boldsymbol{a}) ←\hat{y}に\boldsymbol{X}\boldsymbol{a}を代入\\

&= (y^T - (\boldsymbol{X}\boldsymbol{a})^T)(y - \boldsymbol{X}\boldsymbol{a})\\

&= (y^T - a^T\boldsymbol{X}^T)(y - \boldsymbol{X}\boldsymbol{a})←(\boldsymbol{X}\boldsymbol{a})^T = a^T\boldsymbol{X}^T\\

&= y^Ty - y^T\boldsymbol{X}\boldsymbol{a} - a^T\boldsymbol{X}^Ty + a^T\boldsymbol{X}^T\boldsymbol{X}\boldsymbol{a}←1つ上の式を展開\\

&= y^Ty - 2y^T\boldsymbol{X}\boldsymbol{a} + a^T\boldsymbol{X}^T\boldsymbol{X}\boldsymbol{a}←a^T\boldsymbol{X}^Ty = y^T\boldsymbol{X}\boldsymbol{a}より

\end{align}$この$E$を最小にするために、$E$を$\boldsymbol{a}$で微分し、0になる$\boldsymbol{a}$を求めます。

(なぜ微分して0になるようにするのかは、線形単回帰の記事を参照してください)$

\begin{align}

\frac{∂E}{∂\boldsymbol{a}} &= \frac{∂}{∂\boldsymbol{a}}(y^Ty) - 2\frac{∂}{∂\boldsymbol{a}}(y^T\boldsymbol{X}\boldsymbol{a}) + \frac{∂}{∂\boldsymbol{a}}(a^T\boldsymbol{X}^T\boldsymbol{X}\boldsymbol{a})←\frac{∂}{∂\boldsymbol{a}}(y^Ty)は0になる\\

&= -2\boldsymbol{X}^Ty + [\boldsymbol{X}^T\boldsymbol{X} + (\boldsymbol{X}^T\boldsymbol{X})^T]\boldsymbol{a}←前提知識の3つ目の式のCはここでいうと\boldsymbol{X}^T\boldsymbol{X}にあたる\\

&= -2\boldsymbol{X}^Ty + 2\boldsymbol{X}^T\boldsymbol{X}\boldsymbol{a}

\end{align}

$この誤差関数が0になるから、

$

\begin{align}

-2\boldsymbol{X}^Ty + 2\boldsymbol{X}^T\boldsymbol{X}\boldsymbol{a} = 0\\

2\boldsymbol{X}^T\boldsymbol{X}\boldsymbol{a} = 2\boldsymbol{X}^Ty\\

\boldsymbol{X}^T\boldsymbol{X}\boldsymbol{a} = \boldsymbol{X}^Ty\\

\end{align}

$つまり、求めたかった$\boldsymbol{a}$は下記のように求められます。

$\boldsymbol{a} = (\boldsymbol{X}^T\boldsymbol{X})^{-1} \boldsymbol{X}^Ty$

(3)発展~pythonで実装してみる~

求めたかった$\boldsymbol{a}$は数式で表現できましたが、これだけ提示されても、重回帰はいまいちぴんとこないかもしれないです(私はきませんでした)。

そこで、ここでは、pythonのnumpyを使って、上記の式から解析的に重回帰分析の式を算出してみたいと思います。

◆データセット

(ⅰ)numpyのインポート

import numpy as np(ⅱ)データセット

少し見づらいかもしれないですが、xの左の縦1列が気温、2列目が交通量、3列目が従業員数です。yは売上です。x = np.matrix([[8,100,3], [10,20,5], [6,30,4], [15,15,6], [12,60,6], [16,25,7], [20,40,12], [13,20,8], [24,18,12], [26,30,10], [12,60,7], [18,10,7], [19,8,8], [16,25,6], [20,35,6], [23,90,10], [26,25,12], [28,55,13]]) y = np.matrix([[30], [35], [28], [38], [35], [40], [60], [34], [63], [65], [38], [40], [41], [43], [42], [55], [65], [69]])(ⅲ)重回帰分析

先ほど示した通り、$\boldsymbol{a} = (\boldsymbol{X}^T\boldsymbol{X})^{-1} \boldsymbol{X}^Ty$なので、下記のように記述します。(x.T * x)**-1 * x.T * yそうすると、このように結果が表示されます。つまり、numpy上で計算すると$a_1 = 1.26, a_2 = 0.09, a_3 = 2.47$ということになります。

matrix([[1.26664688],

[0.09371714],

[2.47439799]])これは、scikit-learnで求めた$a_1,a_2,a_3$と数値が微妙に異なりますが、scikit-learnはこのnumpyの計算に、さらにバイアス(というもの)を考慮しているためです。

そこまで突っ込み始めるとより複雑になってくるので、scikit-learnが裏で行っている基本的な計算を知るという意味では、まずは今回レベルのことを押さえておければいいのではと思います。5.まとめ

以上、いかがでしたでしょうか。

私の思いとして、「最初からものすごい複雑なコードなんて見せられても自分で解釈できないから、精度は一旦どうでもいいのでまずはscikit-learn等で基本的な一連の流れを実装してみる」ことは非常に重要だと思っています。ただ、慣れてきたらそれらを裏ではどのように動かしているのか、数学的な背景から理解していくことも非常に重要だと感じています。

とっつきづらい内容も多いと思いますが、少しでも理解の深化の助けとなりましたら幸いですし、私自身もここはもっとしっかり学ばなければいけないと思っていますので、学習を続けることで、より強化した記事を投稿したいと思います。

- 投稿日:2020-02-25T20:33:47+09:00

「ヤジが飛んでくるマインクラフト」DeepLearningで適当テキスト生成 ~modで動かす~

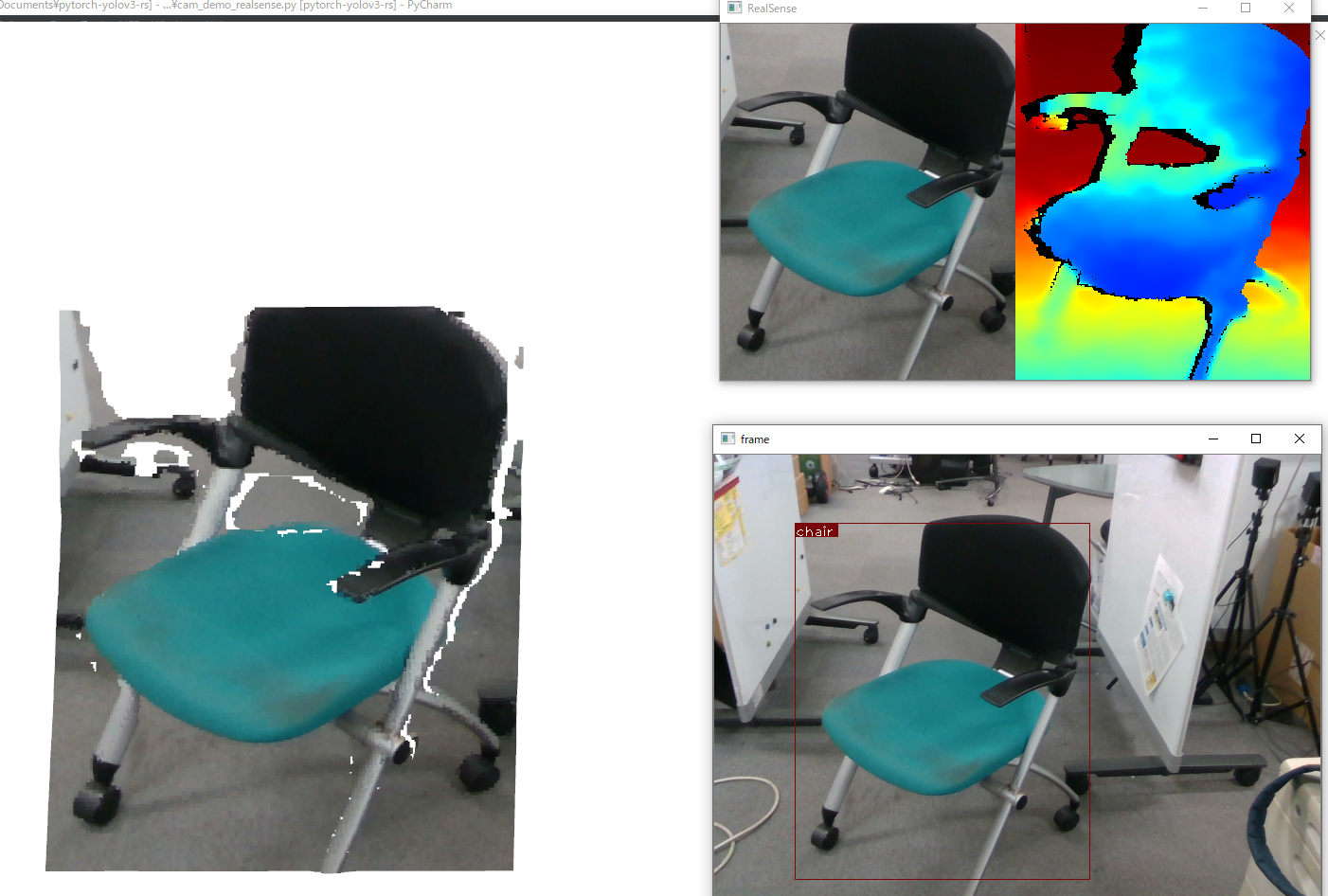

DeepLearningの力を借りて、マイクラのプレイ中、ゲームに関係のある文章を読み上げてくれるソフトを作った。

1つの記事にまとめるのが困難なため、いくつかの記事に分けます。

ここでは、アプリケーション部分について説明します。↓他の記事

やりたいこと

マインクラフトで、近くにゾンビがいるか判定。

ゾンビがいたら、ゾンビに関連する文章を表示。(文章そのものを用意するところは別の記事へ)

マインクラフトmod

マインクラフトは有志の方が制作した、modというものがある。

mod を使えば、かなり自由にゲームを改造することができる。MCreator を使えば、すぐにmod制作が始められる。

簡単な変更なら、コードすら書く必要がない。Python プログラムを組み込みたい

マインクラフト mod は Java で書かれている。

- Java あまり分からない。

- DeepLearningのモデルも動かしたいので、Python が使いたい。

Raspberry Jam Mod(mcpi)

Pythonからマインクラフトを一部操作できる。

いろんなことができる。

しかし、ゲーム情報を取得する部分は微妙。Python と Java で通信

mcpiのコードを見てみる。

Socket通信でやりとりしているらしい。

ポートを指定してごにょごにょするらしい。

Python側は mcpi の Connectionクラスを改造

Java側は ゴリ押しで書く

近くにゾンビがいるかどうか調べる

ようやく、modの実装。

MCreator1.9.1 を使用した。MCreator で新しいワークスペースを作ると mod の雛形が作成される。

GUIで、新しいコマンドを作れる。空のコマンドを作成。

- hogehogeCommandExecuted みたいなやつの、

executeProcedure関数に書く。やりたいことを別の関数に詰め込む。

- Socketを準備

- 継続して、データを取得・送信・受信

コマンド実行時に、別のプロセスで、作った関数を実行するようにする。

- mod 素人(+Java素人)なので、mod と切り分けたかった。

- 脳死で、Thread とかいうのを使ってみる。

ゲーム内情報取得

Minecraft mc = Minecraft.getMinecraft() WorldClient world = mc.world; List<Entity> entities = world.getEntities(Entity.class, (entity)->!entity.isInvisible());これで、ワールド内で透明でない敵mobや動物mobが取得できる。

Entity player = world.getEntityByID(mc.player.getEntityId());そして、プレイヤーのインスタンスもとる。

String minecraftData; for (Entity e: entities) { if (e.getDistance(player) < 8.0f) { minecraftData += e.getName() + ","; } }

getDistanceで Entity 同士の距離が分かる。

近くにいる Entity の名前をgetNameで取得して、送信用の文字列に加えている。表示

マインクラフト内のチャットに文字を出す。

MinecraftServer mcserv; mcserv.getPlayerList().sendMessage(new TextComponentString("hogehoge"));参考になりそうなサイト

mod で気をつけること

バージョンによって少しずつ、ライブラリの仕様が異なる。

ライブラリのソースは、MCreatorからでも見られる。分かる人は直接読んでみてもいいと思う。文字列を用意する。

あらかじめ、どのオブジェクトに関係のある文か分けてあるので、mod からのデータを元にランダムに選ぶ。

その文章の先頭単語を生成モデルに入れて、文を生成してみた。

詳しくは別記事参照。おまけ

表示するだけでは、味気ない。

ゆっくりに喋らせてみた。

簡単に、こんな感じでやった(windows)。subprocess.call("start C:\hoge\softalk\SofTalk.exe /R: /W: "+"読ませたい文章", shell=True)まとめ

マインクラフトのmodは有名なので、解説記事が充実しているかと思ったが、そうでもなかった。

MCreator を使わない環境構築が面倒で、出来ていない。

ガチガチにコーディングしようと思うと不便な気がするので、どうにかしたい。マインクラフトはかなり可能性を秘めているので、みんなもやってみてほしい。

- 投稿日:2020-02-25T18:58:46+09:00

スクリプト言語 KINX/基本編(1) - プログラム基礎・データ型

はじめに

前回の記事から。シリーズ第一弾は普通に基本編。概要は以下の前回の記事を参照してください。

- スクリプト言語 KINX(ご紹介)

- Kinx 基本編(1) - プログラム基礎・データ型(今回)

前回お披露目してみたら★を付けてくださった方がいて、非常に浮かれています。ありがとうございました。温かいお気持ちで行く末を見届けてやってください。

- ここ (https://github.com/Kray-G/kinx) です。Kinx 基本編(1) - プログラム基礎・データ型

プログラム基礎

hello, world

プログラムはトップレベルから記述可能。

hello.kxSystem.println("hello, world.");

hello.kxという名前で保存し、以下のように実行.$ ./kinx hello.kx hello, world.コメント

コメントは C/C++ 形式と Perl のような

#形式と両方利用可能。/* Comment */ // Comment# Comment変数宣言

変数宣言は

varで宣言する。var a = 10;初期化子を使って初期化するが、初期化子を書かなかった場合は

nullとなる。ちなみに Kinx においてはnullとundefinedは同じ意味(賛否あると思うが)。どちらもa.isUndefinedが true となる。データ型一覧

Kinx は動的型付け言語だが、内部に型を持っている。

Type CheckProperty Example Meaning Undefined isUndefinednull 初期化されていない値。 Integer isInteger,isBigInteger100, 0x02 整数。演算では自動的に Big Integer と相互変換される。 Double isDouble1.5 実数。 String isString"aaa", 'bbb' 文字列。 Binary isBinary<1,2,3> バイナリ値。バイトの配列。要素は全て 0x00-0xFF に丸められる。 Array isArray,isObject[1,a,["aaa"]] 配列。扱える型は全て保持可能。 Object isObject{ a: 1, b: x } JSON のようなキーバリュー構造。 Function isFunctionfunction(){},

&() => expr関数。

Undefined以外であればisDefinedで true が返る。尚、真偽値としての

true、falseは整数の 1、0 のエイリアスでしかないのに注意。

Boolean 型というのは特別に定義されていないが、オブジェクトとして真偽を表すTrue、Falseという定数が定義されているので、整数値とどうしても区別したい場合はそちらを使用する。System.println(True ? 1 : 0); // 1 System.println(False ? 1 : 0); // 0ブロックとスコープ

ブロックはスコープを持ち、内側で宣言された変数は外側のブロックからは参照不可。同じ名前で宣言した場合、外側ブロックの同名変数は隠蔽される。

var a = 10; { var a = 100; System.println(a); } System.println(a);この辺が「見た目は JavaScript」であっても中身は JavaScript ではない感じの部分。というか、JavaScript のスコープは変態過ぎて使いづらい。

式

式(エクスプレッション)は、以下の優先順位で四則演算、関数呼び出し、オブジェクト操作等が可能。

# 要素 演算子例 評価方向 1 要素 変数, 数値, 文字列, ... - 2 後置演算子 ++,--,[],.,()左から右 3 前置演算子 !,+,-,++,--左から右 4 パターンマッチ =~,!~左から右 5 べき乗 **右から左 6 乗除 *,/,%左から右 7 加減 +,-左から右 8 ビットシフト <<,>>左から右 9 大小比較 <,>,>=,<=左から右 10 等値比較 ==,!=左から右 11 ビットAND &左から右 12 ビットXOR ^左から右 13 ビットOR |左から右 14 論理AND &&左から右 15 論理OR ||左から右 16 三項演算子 ? :,function(){}左から右 17 代入演算子 =,+=,-=,*=./=.%=,&=,|=,^=,&&=,||=右から左 いくつか特徴を以下に示す。

演算

演算結果によって型が自動的に結果に適応していく。

3/2は1.5になる。num = 3 + 2; // 5 num = 3 - 2; // 1 num = 3 * 2; // 6 num = 3 / 2; // 1.5 num = 3 % 2; // 1インクリメント・デクリメント

前置形式・後置形式があり、C と同様。

var a = 10; System.println(a++); // 10 System.println(++a); // 12 System.println(a--); // 12 System.println(--a); // 10データ型

数値

整数、実数

整数、実数は以下の形式。整数では可読性向上のため任意の場所に

_を挿入可能。_は単に無視される。var i = 2; var j = 100_000_000; var num = 1.234;文字列

基本

ダブルクォートとシングルクォートの両方が使えるが、エスケープしなければならないクォート文字が異なるだけでどちらも同じ意味になる。

var a = "\"aaa\", 'bbb'"; var b = '"aaa", \'bbb\''; System.println(a == b ? "same" : "different"); // same内部式

%{...}の形式で内部に式を持つことができる。for (var i = 0; i < 10; ++i) { System.println("i = %{i}, i * 2 = %{i * 2}"); } // i = 0, i * 2 = 0 // i = 1, i * 2 = 2 // i = 2, i * 2 = 4 // i = 3, i * 2 = 6 // i = 4, i * 2 = 8 // i = 5, i * 2 = 10 // i = 6, i * 2 = 12 // i = 7, i * 2 = 14 // i = 8, i * 2 = 16 // i = 9, i * 2 = 18フォーマッタ

文字列に対する

%演算子はフォーマッタ・オブジェクトを作成する。var fmt = "This is %1%, I can do %2%."; System.println(fmt % "Tom" % "cooking");

%1%の1はプレースホルダ番号を示し、%演算子で適用した順に合わせて整形する。適用場所が順序通りであれば、C の printf と同様の指定の仕方も可能。さらに、C の printf と同じ指定子を使いながら同時にプレースホルダも指定したい場合は、$の前に位置指定子を書き、'$' で区切って記述する。例えば、16進数で表示したい場合は以下のようにする。var fmt = "This is %2%, I am 0x%1$02x years old in hex."; System.println(fmt % 27 % "John"); // This is John, I am 0x1b years old in hex.フォーマッタ・オブジェクトに後から値を適用していく場合は、

%=演算子で適用していく。var fmt = "This is %1%, I can do %2%."; fmt %= "Tom"; fmt %= "cooking"; System.println(fmt);実際のフォーマット処理は、

System.println等で表示するとき、文字列との加算等が行われるとき、に実際に実行される。Raw 文字列

文字列内部ではなく、

%{...}で文字列を記載することで Raw 文字列を作成することが可能。%-{...}を使うと、先頭と末尾の改行文字をトリミングする。ヒアドキュメントのようにも使えるので、ヒアドキュメントはサポートしていない。また、%<...>、%(...)、%[...]を使うこともできる。var a = 100; var b = 10; var str = %{ This is a string without escaping control characters. New line is available in this area. { and } can be nested here. }; System.println(str); var str = %-{ This is a string without escaping control characters. New line is available in this area. But newlines at the beginning and the end are removed when starting with '%-'. }; System.println(str);

\でエスケープする必要があるのは、内部式を使う場合%{の%に対するものと、ネストした形にならないケースでのクォート文字である{や}に対するものだけとなる。また、カッコは対応する閉じカッコでクォートするが、以下の文字を使ったクォートも可能である。その場合は、開始文字と終了文字は同じ文字となる。例えば、

%|...|のような形で使用する。

|,!,^,~,_,.,,,+,*,@,&,$,:,;,?,',".正規表現リテラル

正規表現リテラルは

/.../の形式で使う。リテラル内の/は\でエスケープする必要がある。以下が例。var a = "111/aaa/bbb/ccc/ddd"; while (group = (a =~ /\w+\//)) { for (var i = 0, len = group.length(); i < len; ++i) { System.println("found[%2d,%2d) = %s" % group[i].begin % group[i].end % a.subString(group[i].begin, group[i].end - group[i].begin)); } }

/を多用するような正規表現の場合、%mプレフィックスを付け、別のクォート文字を使うことで回避できる。例えば%m(...)といった記述が可能。これを使って上記を書き直すと、以下のようになる。var a = "111/aaa/bbb/ccc/ddd"; while (group = (a =~ %m(\w+/))) { for (var i = 0, len = group.length(); i < len; ++i) { System.println("found[%2d,%2d) = %s" % group[i].begin % group[i].end % a.subString(group[i].begin, group[i].end - group[i].begin)); } }尚、正規表現リテラルを

while等の条件式に入れることができるが注意点があるので補足しておく。例えば以下のように記述した場合、strの文字列に対してマッチしなくなるまでループを回すことができる(groupにはキャプチャ一覧が入る)。その際、最後のマッチまで実行せずに途中でbreak等でループを抜けると正規表現リテラルの対象文字列が次回のループで正しくリセットされない、という状況が発生する。while (group = (str =~ /ab+/)) { /* block */ }正規表現リテラルがリセットされるタイミングは以下の 2 パターン。

- 初回(前回のマッチが失敗して再度式が評価された場合を含む)。

strの内容が変化した場合。将来改善を検討するかもしれないが、現在は上記の制約があることに注意。

配列

配列は任意の要素を保持するリスト。インデックスでアクセスできる。またインデックスに負の数を与えることで末尾からアクセスすることもできる。

var a = [1,2,3]; var b = [a, 1, 2]; System.println(b[0][2]); // 3 System.println(a[-1]); // 3配列構造は左辺値で使用すると右辺値の配列を個々の変数に取り込むことが可能。これを使用して値のスワップも可能。

[a, b] = [b, a]; // Swapスプレッド(レスト)演算子を使っての分割も可能。

[a, ...b] = [1, 2, 3, 4, 5]; // a = 1 // b = [2, 3, 4, 5]尚、以下の書き方はできない。変数は宣言なしで使用できる(最初に代入された時点で生成される)ため、

varを付けない形で直接記述することは可能。ただしその際、外部のスコープで定義されていた場合、外側のスコープの変数の内容が書き換わってしまうことに注意。スコープで変数へのアクセス範囲を閉じたい場合は、予めvar a, b;と宣言してから使うことで回避可能。// var [a, ...b] = [1, 2, 3, 4, 5]; // error. var a = 3, b = [4], x = 3, y = [4]; { var a, b; [a, ...b] = [1, 2, 3, 4, 5]; // a = 1 // b = [2, 3, 4, 5] [x, ...y] = [1, 2, 3, 4, 5]; // x = 1 // y = [2, 3, 4, 5] [z] = [1, 2, 3, 4, 5]; // okay z = 1, but scoped out... } System.println("a = ", a); // 3 System.println("b = ", b[0]); // 4 System.println("x = ", x); // 1 System.println("y = ", y[0]); // 2宣言と同時に使えると便利とは思うので、将来改善するかもしれない。

バイナリ

バイナリはバイト配列であり、

<...>の形式で記述する。全ての要素は 0x00 ~ 0xFF の範囲にアジャストされ、配列のようにアクセス可能。バイナリと配列は相互にスプレッド演算子で分割、結合することが可能。

var bin = <0x01, 0x02, 0x03, 0x04>; var ary = [...bin]; // ary := [1, 2, 3, 4] var ary = [10, 11, 12, 257]; var bin = <...ary>; // bin := <0x0a, 0x0b, 0x0c, 0x01>ただし、バイナリになった瞬間に 0x00-0xFF に丸められるので注意。

オブジェクト

いわゆる JSON。ただし、ソースコード上のキー文字列に対してクォートする必要は無い(しても良い)。

var a = { a: 100 }; a.b = 1_000; a["c"] = 10_000; System.println(a.a); // 100 System.println(a.b); // 1000 System.println(a.c); // 10000内部的に実はオブジェクトと配列は同じであり、両方の値を同時に保持できる。

var a = { a: 100 }; a.b = 1_000; a["c"] = 10_000; a[1] = 10; System.println(a[1]); // 10 System.println(a.a); // 100 System.println(a.b); // 1000 System.println(a.c); // 10000おわりに

今回はここまで。結構疲れた。

非常に一般的な話ばかりで面白くないのだが、まずはこういうところに触れた上で色々な解説しとかないと土台が良く分からなくなりそうなので頑張ってみた。とりあえず、次は制御構造に触れて、一通りのプログラムが構築できるところまでを目指そう。そこまで行ったら関数とかクラスとかクロージャとか個別の解説をしてみる予定。

例によって★が増えるといいな、と宣伝しておく。

そして書きながらバグを見つけ修正するという...。

- 投稿日:2020-02-25T18:49:58+09:00

[python]List内の値の順位を昇順/降順で取得する

記事の内容

PythonのListの値の順位を昇順/降順で取得したい。

昇順は調べるとすぐに見つかりましたが、降順は少し工夫が必要だったのでメモとして残します。コード

早速、コードです。

sample.pyfrom scipy.stats import rankdata # 対象のデータ array = [10,30,30,40,20] # rankdataでインデックス毎の順位を取得 asc = rankdata(array) # 昇順の表示 print(type(asc)) print(asc.astype(float)) # 降順の計算 desc = (len(asc) - asc + 1).astype(float) # 降順の表示 print(type(desc)) print(desc)降順はrankdataに降順で取得する処理が実装されていない様なので計算する必要がありました。

色々試してみた結果、これが一番簡単に出来そうな気がします。以下、実行結果です。

<class 'numpy.ndarray'> [1. 3. 5. 4. 2.] <class 'numpy.ndarray'> [5. 3. 1. 2. 4.]astypeをastype(int)に変更すると

<class 'numpy.ndarray'> [1 3 5 4 2] <class 'numpy.ndarray'> [5 3 1 2 4]こうなります。

この状態で同じ値が入っていると・・

# 対象のデータ array = [10,30,30,40,20]<class 'numpy.ndarray'> [1 3 3 5 2] <class 'numpy.ndarray'> [5 2 2 1 4]こうなります。結果が変わってしまいました・。

floatのままだと<class 'numpy.ndarray'> [1. 3.5 3.5 5. 2. ] <class 'numpy.ndarray'> [5. 2.5 2.5 1. 4. ]こうなります。

データに被りがない時、限定のやり方ということで・・。

追記

konandoirusa さんよりご指摘頂いた方法の方が圧倒的に簡単なので追記

sample.pyimport numpy as np from scipy.stats import rankdata # 対象のデータ array = [10,30,30,40,20] # 昇順 print(rankdata(np.array(array))) # 降順 print(rankdata(-np.array(array)))実行結果

[1. 3.5 3.5 5. 2. ] [5. 2.5 2.5 1. 4. ]

- 投稿日:2020-02-25T18:48:07+09:00

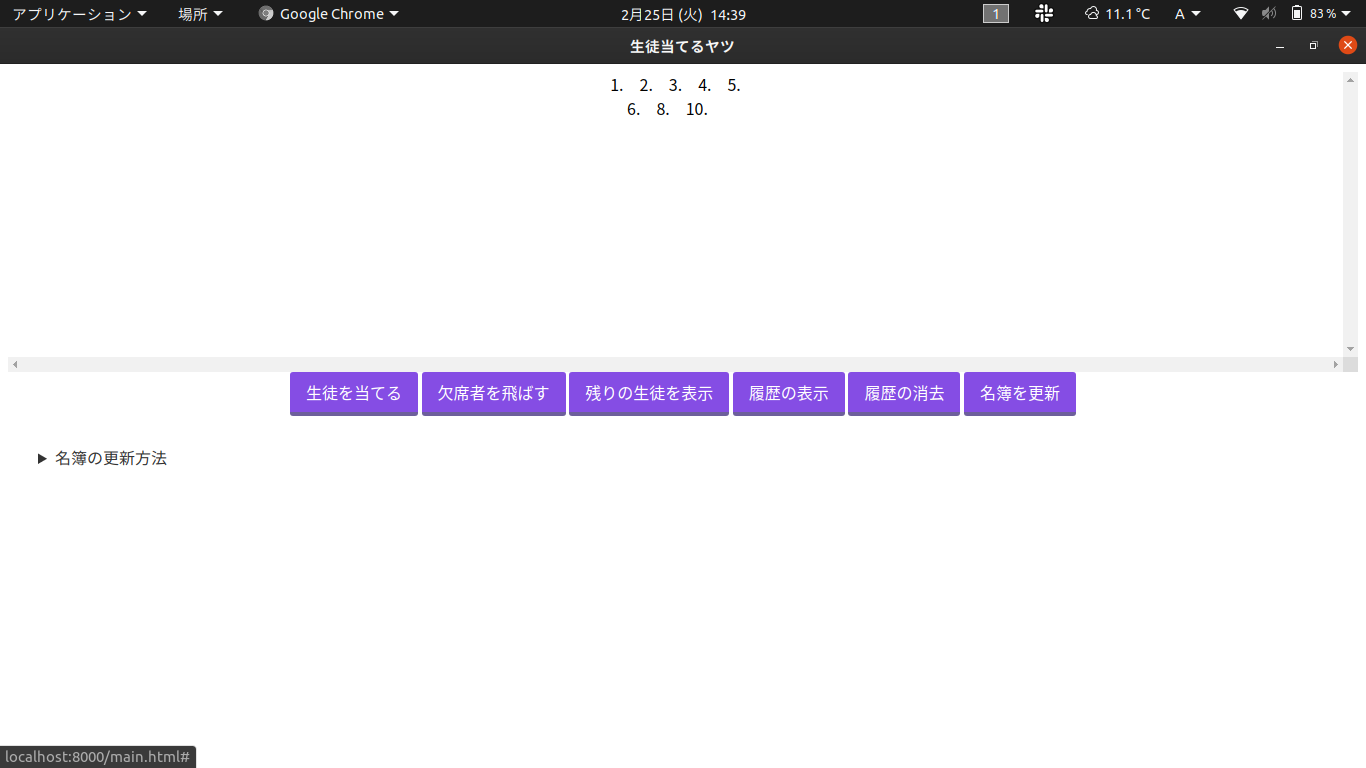

pythonで生徒を当てるアプリをつくる-GUI版

はじめに

以前投稿したpythonで生徒を当てるアプリをつくるをGUIソフトにしたってだけの記事.

プログラム

main.py data/ history.txt list.txt list_raw.txt web/ main.html css/ style.css js/ eel.js

main.py

main.pyimport locale import eel import random import pickle import os import sys import datetime from tkinter import filedialog, Tk import platform import copy def main(): eel.init("web") eel.start("main.html") Student_names = [] Student_FILENAME = "./data/list.txt" Student_FILENAME_raw = "./data/list_raw.txt" # Student @eel.expose def Student_load(): with open(select_file(), "r") as f: global Student_names Student_names = f.read().splitlines() Student_save(Student_FILENAME) Student_save(Student_FILENAME_raw) @eel.expose def Student_reset(): Student_names_load(Student_FILENAME_raw) @eel.expose def Student_show(): Student_names_load(Student_FILENAME) name_ls = "" a = 1 for name in Student_names: if a % 5 == 0: name_ls = name_ls + name + "<br>" else: name_ls = name_ls + name + " " a += 1 return name_ls @eel.expose def Student_choice(): Student_names_load(Student_FILENAME) global Student_names_raw Student_names_raw = copy.deepcopy(Student_names) if not Student_names: return global name name = random.choice(Student_names) Student_names.remove(name) if Student_names == []: Student_names_load(Student_FILENAME_raw) History_add(name) Student_save(Student_FILENAME) return name @eel.expose def Student_save(FILENAME): f = open(FILENAME, 'wb') pickle.dump(Student_names, f) @eel.expose def Student_names_load(FILENAME): f = open(FILENAME, "rb") global Student_names Student_names = pickle.load(f) # History History_FILENAME = "./data/history.txt" History_data = [] @eel.expose def History_load(): with open(History_FILENAME, "r") as f: global History_data History_data = f.read().splitlines() @eel.expose def History_save(): with open(History_FILENAME, "w") as f: for history in History_data: print(history, file=f) @eel.expose def History_show(): history_ls = "" History_load() for history in History_data: history_ls = history + "<br>" + history_ls return history_ls locale.setlocale(locale.LC_ALL, '') @eel.expose def History_add(name): now = datetime.datetime.now() History_data.append(f"{now:%m月%d日}:{name}") History_save() @eel.expose def History_cancel(): History_data.pop() History_save() global Student_names Student_names = copy.deepcopy(Student_names_raw) Student_save(Student_FILENAME) @eel.expose def History_clear(): global History_data History_data = [] History_save() # 名簿読み込み # ダイアログ用のルートウィンドウの作成 # (root自体はeelのウィンドウとは関係ないので非表示にしておくのが望ましい) root = Tk() # ウィンドウサイズを0にする root.geometry("0x0") # ウィンドウのタイトルバーを消す root.overrideredirect(1) # ウィンドウを非表示に root.withdraw() system = platform.system() @eel.expose def select_file(): # Windowsの場合withdrawの状態だとダイアログも # 非表示になるため、rootウィンドウを表示する if system == "Windows": root.deiconify() # macOS用にダイアログ作成前後でupdate()を呼ぶ root.update() # ダイアログを前面に # topmost指定(最前面) root.attributes('-topmost', True) root.withdraw() root.lift() root.focus_force() path_str = filedialog.askopenfilename() root.update() if system == "Windows": # 再度非表示化(Windowsのみ) root.withdraw() #path = Path(path_str) return path_str if __name__ == '__main__': main()

main.html

main.html<html> <head> <meta charset="UTF-8"> <title>生徒当てるヤツ</title> <link rel="stylesheet" type="text/css" href="./css/style.css"> <script type="text/javascript" src="/eel.js"></script> <script type="text/javascript"> async function Student_choice() { var demo2 = document.getElementById("div0"); demo2.innerHTML = ""; div0.insertAdjacentHTML('afterbegin', '<div id="name"></div>'); let val = await eel.Student_choice()(); var doc0 = document.getElementById("name"); doc0.innerHTML = val; } async function Student_load() { eel.Student_load(); } async function Student_show() { let val = await eel.Student_show()(); var doc0 = document.getElementById("div0"); doc0.innerHTML = val; } async function History_show() { let val = await eel.History_show()(); var doc0 = document.getElementById("div0"); doc0.innerHTML = val; } async function History_clear() { let val = await eel.History_clear()(); var doc0 = document.getElementById("div0"); doc0.innerHTML = val; } async function History_cancel() { let val = await eel.History_cancel()(); var doc0 = document.getElementById("div0"); doc0.innerHTML = val; } </script> </head> <body> <center> <div id="div0"> </div> <div class="bottom"> <a href="#" onclick="Student_choice()" class="btn-square">生徒を当てる</a> <a href="#" onclick="History_cancel()" class="btn-square">欠席者を飛ばす</a> <a href="#" onclick="Student_show()" class="btn-square">残りの生徒を表示</a> <a href="#" onclick="History_show()" class="btn-square">履歴の表示</a> <a href="#" onclick="History_clear()" class="btn-square">履歴の消去</a> <a href="#" onclick="Student_load()" class="btn-square">名簿を更新</a> </div> </center> <div class='markdown-preview' data-use-github-style> <details> <summary>名簿の更新方法</summary> <div> <h1 id="名簿の更新方法">名簿の更新方法</h1> <h3 id="1">1</h3> <p>任意のファイル名のテキストファイル(*.txt)を作成します.</p> <h3 id="2">2</h3> <p>その中に<br> 1.名前<br> 2.名前<br> ・<br> ・<br> ・<br> と入力します.</p> <h3 id="3">3</h3> <p>名簿を更新をクリックし,テキストファイルを選択する.</p> </div> </details> </div> </html>

style.css