- 投稿日:2020-02-08T20:17:50+09:00

とりあえずLaradockで

対象者

とりあえずインフラとかDockerとか慣れてなくてよく分からないけど、手早くLaravelを動かせればいいやーって人向けです。

Laradockとは

公式サイトには「Laradockは、Dockerに基づく完全なPHP開発環境です。」とあります。

Laradock is a full PHP development environment based on Docker.

公式

前提

- パソコンがある

- Wifiがある

※あとDockerのいんすとーるとかはやっといてくださーい、gitも要るよー。

手順

1. ローカルでディレクトリを作成

- 任意のディレクトリ作成

$ mkdir laradock $ cd laradock/2. LaradockのリポジトリをClone

GithubからLaradockのリポジトリをクローン

$ git clone https://github.com/Laradock/laradock.git laradock-practice $ cd laradock-practice/laradock-practiceの部分は、好きに変えてください。

デフォルトでは「laradock」というディレクトリになりますが、引数に名前を渡すとオリジナルのものができあがります。名前はつけておいたほうがいいっすね。3. 各種設定 (Laradock)

- 設定ファイルのコピー作成

$ cp env-example .env.env(設定ファイル)を開く

$ vi .env以下の項目を探し、修正してください

修正前

APP_CODE_PATH_HOST=../修正後

APP_CODE_PATH_HOST=../laradock-projectlaradock-projectの部分はこれから作るLaravelプロジェクトの名前にしてください。

LaravelのWebサーバー上で同期するディレクトリを指定しています。

これをちゃんと指定してあげないとアクセス時404エラーになります。※viコマンドはコマンドでファイルの編集ができます。編集したい箇所で「i」を入力するとインサートモードになり文字が打てるようになります。インサートモードを終了するには「esc」ボタンを入力します。その後、編集したファイルを保存し、終了するには「:」と「wq」を立て続けに入力してください。

修正前

MYSQL_VERSION=latest MYSQL_DATABASE=default MYSQL_USER=default MYSQL_PASSWORD=secret MYSQL_PORT=3306 MYSQL_ROOT_PASSWORD=root修正後

MYSQL_VERSION=5.7(別に5.7じゃなくても) MYSQL_DATABASE=このへんは MYSQL_USER=じゆうに MYSQL_PASSWORD=きめちゃってください MYSQL_PORT=3306 MYSQL_ROOT_PASSWORD=root※詳しく調べていませんが、mysqlのverをlatestで最新にするとセキュリティ上の問題でうまく接続できないらしいです。僕はちなみに、5.7にしているのにうまく動かない時があり、なぜだろうと思っていたら「5.7t」と記述しており、5.7トンという重さを指定してしまっていたことがありました。

- laradock-practice/nginx/sites/default.confの変更

これはnginxに関する設定ファイルです。

nginx起動時に表示するファイルなどを指定できるのですが、パスの指定がうまくいっていない場合があるので、修正する必要があれば書き換えましょう。

着目してもらいたいのは一部分です。

以下のような修正前の状態になっていれば、修正してください。

laradock-projectの部分はそれぞれ作成されるLaravelプロジェクトの名前を指定してください。修正前

root /var/www/public;修正後

root /var/www/laradock-project/public;4. コンテナ立ち上げ〜プロジェクトの作成

- コンテナの立ち上げ

$ docker-compose up -d mysql nginxdocker-compose upコマンドはdocker-compose.ymlに書かれた情報をもとに処理を実行します(コンテナイメージの作成からコンテナの立ち上げなど。引数なしだと記述されている内容すべてが実行されるので、ひとまずDBサーバのmysqlとwebサーバのnginxを指定します。

※-dはデタッチモード(バックグラウンドで起動します)

- コンテナの起動確認

以下のように立ち上がっていれば大丈夫です。

$ docker ps CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 82e444c0ae67 laradock_nginx "/bin/bash /opt/star…" 6 seconds ago Up 4 seconds 0.0.0.0:80-81->80-81/tcp, 0.0.0.0:443->443/tcp laradock_nginx_1 bd531621d6a3 laradock_php-fpm "docker-php-entrypoi…" 7 seconds ago Up 6 seconds 9000/tcp laradock_php-fpm_1 1665d8a83f3b laradock_workspace "/sbin/my_init" 8 seconds ago Up 7 seconds 0.0.0.0:2222->22/tcp laradock_workspace_1 d8b22e74c28f docker:dind "dockerd-entrypoint.…" 10 seconds ago Up 8 seconds 2375-2376/tcp laradock_docker-in-docker_1 7af2df7ebe17 laradock_mysql "docker-entrypoint.s…" 10 seconds ago Up 8 seconds 0.0.0.0:3306->3306/tcp, 33060/tcp laradock_mysql_1

- ワークスペースコンテナに入る

ワークスペースコンテナに入ります。exec、bashでそのコンテナに対してコマンドが叩けるようになります。

ワークスペースとはLaravelの開発を進めるにあたって必要なcomposerなどのツール類が用意された作業スペースみたいなところです。

デフォルトだとrootでワークスペースに入ることになるのですが、後ほどcomposerコマンドを実行した際に、怒られてしまうので、怒られるのが苦手な人は--user=laradockとかでlaradockユーザーとしてワークスペースに入ってください。

$ docker-compose exec --user=laradock workspace bash .../var/www$

- Laravelプロジェクトの作成

以下のコマンドで、Laravelのプロジェクトがlaradockディレクトリと同じ階層の中に作成されます。

この実行内容だと最新verのLaravelでプロジェクトが作られます。ver指定したい場合は調べてください。.../var/www$ composer create-project laravel/laravel laradock-project ...以下略 Application key set successfully.

- プロジェクト内へ移動

プロジェクト内に移動します。

.../var/www$ cd laradock-project/5. 各種設定(Laravelプロジェクト)

- 設定ファイルの修正

.../var/www$ vi .env以下のように修正

修正前

DB_CONNECTION=mysql DB_HOST=127.0.0.1 DB_PORT=3306 DB_DATABASE=laravel DB_USERNAME=root DB_PASSWORD=修正後

DB_CONNECTION=mysql DB_HOST=mysql DB_PORT=3306 DB_DATABASE=このへんはさっきつくった DB_USERNAME=Laradockの.envの内容と DB_PASSWORD=合わせてください.envの内容は先ほど作ったLaradockの方の内容と整合性が取れている必要がありますので合わせておいてください。

7. MySQLの確認

MySQLの設定がうまくいっているかを確認します。

- MySQLコンテナへ入る

Ctl + dでワークスペースコンテナを出て、MySQLコンテナに入ります。

$ docker-compose exec mysql bash

- MySQLへ接続

MySQLへ、接続します。defaultの部分は先ほど.envファイルで設定したユーザーネームを指定し、その後パスワードを聞かれるので、同じように.envで設定したパスワードを入力してください。うまくログインできればsqlコマンドが打てる画面に移り変わります。

# mysql -u default -p Enter password: Welcome to the MySQL monitor. Commands end with ; or \g. Your MySQL connection id is 4 Server version: 5.7.27 MySQL Community Server (GPL) Copyright (c) 2000, 2019, Oracle and/or its affiliates. All rights reserved. Oracle is a registered trademark of Oracle Corporation and/or its affiliates. Other names may be trademarks of their respective owners. Type 'help;' or '\h' for help. Type '\c' to clear the current input statement. mysql>

- データベースの確認

うまく設定できていれば、.envで設定したデータベースが作られているはずです

mysql> show databases; +--------------------+ | Database | +--------------------+ | information_schema | | default | +--------------------+ 2 rows in set (0.02 sec)

- ユーザーの確認(rootで入った場合のみ行えます)

こちらも設定できていれば、.envで設定したユーザーが登録されていることが確認できますが、mysqlにroot権限で接続している必要があります。

mysql> select User from mysql.user; +---------------+ | User | +---------------+ | default | | root | | mysql.session | | mysql.sys | | root | +---------------+ 5 rows in set (0.02 sec)

- マイグレーションチェック

マイグレーションを実行し、データベースの接続が上手くいっているかを確認します。

Laravelにおけるマイグレーションとはデータベースのバージョン管理機能のことです。MySQL確認の延長ですが、一旦MySQLコンテナから抜け、ワークスペースコンテナに入り、プロジェクト内に移動して以下のコマンドを実行します。

データベース接続がうまくいっていればマイグレーションが実行されます。

$ php artisan migrate Migration table created successfully. Migrating: 2014_10_12_000000_create_users_table Migrated: 2014_10_12_000000_create_users_table (0.07 seconds) Migrating: 2014_10_12_100000_create_password_resets_table Migrated: 2014_10_12_100000_create_password_resets_table (0.06 seconds) Migrating: 2019_08_19_000000_create_failed_jobs_table Migrated: 2019_08_19_000000_create_failed_jobs_table (0.03 seconds)ここまでの流れで上手くいかない場合

- Laradock、Laravelプロジェクトの各.envファイルの整合性が取れていない可能性

→.envファイルの設定がそれぞれ同じになっているかを確認し、合っていなければ合わせてください。

- ストレージデータの影響

→laradockでDBを使用する際のストレージがデフォルトで、~/.laradock/dataに設定されています。~/.laradock/dataにmysqlというディレクトリが存在しているので一旦削除してやり直してみてください。

補足

デフォルトで~/.laradock/dataが設定されていると説明しましたが、これでは他にLaradockを使ってプロジェクトを作成した際に同じ場所を参照してしまうので変えた方がいいっぽいです。ここでは詳しく解説はしませんので詳細は調べてください。

- .envの書き換え等が反映されていない可能性

コンテナを立ち上げたまま、.env等の設定を書き換えただけでは内容が反映されません。

一度、コンテナを起動させ直しましょう。再起動

$ docker-compose restartダメなら停止と削除〜起動

$ docker-compose down$ docker-compose up -d mysql nginx8. プロジェクトの起動確認

- localhostへアクセス

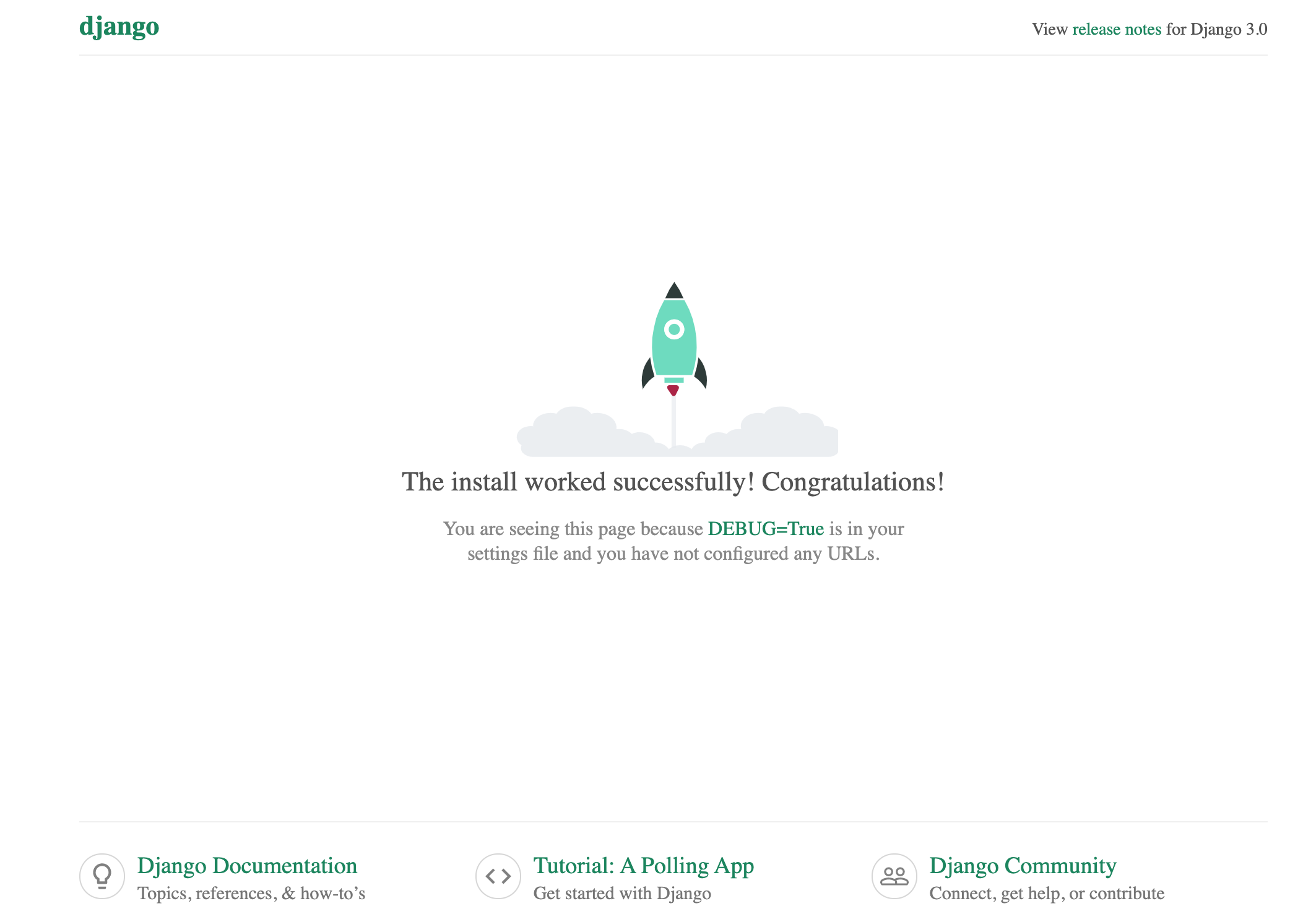

nginxのコンテナを立ち上がっている状態でlocalhostへアクセスします。うまくいっていれば、Laravelのトップページが表示されます。

上手くいかない場合

- Laradockの.envファイルのAPP_CODE_PATH_HOSTの設定が正しくできていない

→プロジェクトが存在するパスをちゃんと記述してあげてください。

- nginxのdefault.confのパス指定が上手くできていない

→上記に手順を記載していますので、やり直してください。

- nginxコンテナが立ち上がっていない

→docker psコマンドで確認し、立ち上がっていなければ、立ち上げてください。

ここまでくればとりあえずの環境構築は完了です!

あとは煮るなり焼くなり好きにしてください!

- 投稿日:2020-02-08T20:17:50+09:00

とりあえずLaradock

対象者

とりあえずインフラとかDockerとか慣れてなくてよく分からないけど、手早くLaravelを動かせればいいやーって人向けです。

Laradockとは

公式サイトには「Laradockは、Dockerに基づく完全なPHP開発環境です。」とあります。

Laradock is a full PHP development environment based on Docker.

公式

前提

- パソコンがある

- Wifiがある

※あとDockerのいんすとーるとかはやっといてくださーい、gitも要るよー。

手順

1. ローカルでディレクトリを作成

- 任意のディレクトリ作成

$ mkdir laradock $ cd laradock/2. LaradockのリポジトリをClone

GithubからLaradockのリポジトリをクローン

$ git clone https://github.com/Laradock/laradock.git laradock-practice $ cd laradock-practice/laradock-practiceの部分は、好きに変えてください。

デフォルトでは「laradock」というディレクトリになりますが、引数に名前を渡すとオリジナルのものができあがります。名前はつけておいたほうがいいっすね。3. 各種設定 (Laradock)

- 設定ファイルのコピー作成

$ cp env-example .env.env(設定ファイル)を開く

$ vi .env以下の項目を探し、修正してください

修正前

APP_CODE_PATH_HOST=../修正後

APP_CODE_PATH_HOST=../laradock-projectlaradock-projectの部分はこれから作るLaravelプロジェクトの名前にしてください。

LaravelのWebサーバー上で同期するディレクトリを指定しています。

これをちゃんと指定してあげないとアクセス時404エラーになります。※viコマンドはコマンドでファイルの編集ができます。編集したい箇所で「i」を入力するとインサートモードになり文字が打てるようになります。インサートモードを終了するには「esc」ボタンを入力します。その後、編集したファイルを保存し、終了するには「:」と「wq」を立て続けに入力してください。

修正前

MYSQL_VERSION=latest MYSQL_DATABASE=default MYSQL_USER=default MYSQL_PASSWORD=secret MYSQL_PORT=3306 MYSQL_ROOT_PASSWORD=root修正後

MYSQL_VERSION=5.7(別に5.7じゃなくても) MYSQL_DATABASE=このへんは MYSQL_USER=じゆうに MYSQL_PASSWORD=きめちゃってください MYSQL_PORT=3306 MYSQL_ROOT_PASSWORD=root※詳しく調べていませんが、mysqlのverをlatestで最新にするとセキュリティ上の問題でうまく接続できないらしいです。僕はちなみに、5.7にしているのにうまく動かない時があり、なぜだろうと思っていたら「5.7t」と記述しており、5.7トンという重さを指定してしまっていたことがありました。

- laradock-practice/nginx/sites/default.confの変更

これはnginxに関する設定ファイルです。

nginx起動時に表示するファイルなどを指定できるのですが、パスの指定がうまくいっていない場合があるので、修正する必要があれば書き換えましょう。

着目してもらいたいのは一部分です。

以下のような修正前の状態になっていれば、修正してください。

laradock-projectの部分はそれぞれ作成されるLaravelプロジェクトの名前を指定してください。修正前

root /var/www/public;修正後

root /var/www/laradock-project/public;4. コンテナ立ち上げ〜プロジェクトの作成

- コンテナの立ち上げ

$ docker-compose up -d mysql nginxdocker-compose upコマンドはdocker-compose.ymlに書かれた情報をもとに処理を実行します(コンテナイメージの作成からコンテナの立ち上げなど。引数なしだと記述されている内容すべてが実行されるので、ひとまずDBサーバのmysqlとwebサーバのnginxを指定します。

※-dはデタッチモード(バックグラウンドで起動します)

- コンテナの起動確認

以下のように立ち上がっていれば大丈夫です。

$ docker ps CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 82e444c0ae67 laradock_nginx "/bin/bash /opt/star…" 6 seconds ago Up 4 seconds 0.0.0.0:80-81->80-81/tcp, 0.0.0.0:443->443/tcp laradock_nginx_1 bd531621d6a3 laradock_php-fpm "docker-php-entrypoi…" 7 seconds ago Up 6 seconds 9000/tcp laradock_php-fpm_1 1665d8a83f3b laradock_workspace "/sbin/my_init" 8 seconds ago Up 7 seconds 0.0.0.0:2222->22/tcp laradock_workspace_1 d8b22e74c28f docker:dind "dockerd-entrypoint.…" 10 seconds ago Up 8 seconds 2375-2376/tcp laradock_docker-in-docker_1 7af2df7ebe17 laradock_mysql "docker-entrypoint.s…" 10 seconds ago Up 8 seconds 0.0.0.0:3306->3306/tcp, 33060/tcp laradock_mysql_1

- ワークスペースコンテナに入る

ワークスペースコンテナに入ります。exec、bashでそのコンテナに対してコマンドが叩けるようになります。

ワークスペースとはLaravelの開発を進めるにあたって必要なcomposerなどのツール類が用意された作業スペースみたいなところです。

デフォルトだとrootでワークスペースに入ることになるのですが、後ほどcomposerコマンドを実行した際に、怒られてしまうので、怒られるのが苦手な人は--user=laradockとかでlaradockユーザーとしてワークスペースに入ってください。

$ docker-compose exec --user=laradock workspace bash .../var/www$

- Laravelプロジェクトの作成

以下のコマンドで、Laravelのプロジェクトがlaradockディレクトリと同じ階層の中に作成されます。

この実行内容だと最新verのLaravelでプロジェクトが作られます。ver指定したい場合は調べてください。.../var/www$ composer create-project laravel/laravel laradock-project ...以下略 Application key set successfully.

- プロジェクト内へ移動

プロジェクト内に移動します。

.../var/www$ cd laradock-project/5. 各種設定(Laravelプロジェクト)

- 設定ファイルの修正

.../var/www$ vi .env以下のように修正

修正前

DB_CONNECTION=mysql DB_HOST=127.0.0.1 DB_PORT=3306 DB_DATABASE=laravel DB_USERNAME=root DB_PASSWORD=修正後

DB_CONNECTION=mysql DB_HOST=mysql DB_PORT=3306 DB_DATABASE=このへんはさっきつくった DB_USERNAME=Laradockの.envの内容と DB_PASSWORD=合わせてください.envの内容は先ほど作ったLaradockの方の内容と整合性が取れている必要がありますので合わせておいてください。

7. MySQLの確認

MySQLの設定がうまくいっているかを確認します。

- MySQLコンテナへ入る

Ctl + dでワークスペースコンテナを出て、MySQLコンテナに入ります。

$ docker-compose exec mysql bash

- MySQLへ接続

MySQLへ、接続します。defaultの部分は先ほど.envファイルで設定したユーザーネームを指定し、その後パスワードを聞かれるので、同じように.envで設定したパスワードを入力してください。うまくログインできればsqlコマンドが打てる画面に移り変わります。

# mysql -u default -p Enter password: Welcome to the MySQL monitor. Commands end with ; or \g. Your MySQL connection id is 4 Server version: 5.7.27 MySQL Community Server (GPL) Copyright (c) 2000, 2019, Oracle and/or its affiliates. All rights reserved. Oracle is a registered trademark of Oracle Corporation and/or its affiliates. Other names may be trademarks of their respective owners. Type 'help;' or '\h' for help. Type '\c' to clear the current input statement. mysql>

- データベースの確認

うまく設定できていれば、.envで設定したデータベースが作られているはずです

mysql> show databases; +--------------------+ | Database | +--------------------+ | information_schema | | default | +--------------------+ 2 rows in set (0.02 sec)

- ユーザーの確認(rootで入った場合のみ行えます)

こちらも設定できていれば、.envで設定したユーザーが登録されていることが確認できますが、mysqlにroot権限で接続している必要があります。

mysql> select User from mysql.user; +---------------+ | User | +---------------+ | default | | root | | mysql.session | | mysql.sys | | root | +---------------+ 5 rows in set (0.02 sec)

- マイグレーションチェック

マイグレーションを実行し、データベースの接続が上手くいっているかを確認します。

Laravelにおけるマイグレーションとはデータベースのバージョン管理機能のことです。MySQL確認の延長ですが、一旦MySQLコンテナから抜け、ワークスペースコンテナに入り、プロジェクト内に移動して以下のコマンドを実行します。

データベース接続がうまくいっていればマイグレーションが実行されます。

$ php artisan migrate Migration table created successfully. Migrating: 2014_10_12_000000_create_users_table Migrated: 2014_10_12_000000_create_users_table (0.07 seconds) Migrating: 2014_10_12_100000_create_password_resets_table Migrated: 2014_10_12_100000_create_password_resets_table (0.06 seconds) Migrating: 2019_08_19_000000_create_failed_jobs_table Migrated: 2019_08_19_000000_create_failed_jobs_table (0.03 seconds)ここまでの流れで上手くいかない場合

- Laradock、Laravelプロジェクトの各.envファイルの整合性が取れていない可能性

→.envファイルの設定がそれぞれ同じになっているかを確認し、合っていなければ合わせてください。

- ストレージデータの影響

→laradockでDBを使用する際のストレージがデフォルトで、~/.laradock/dataに設定されています。~/.laradock/dataにmysqlというディレクトリが存在しているので一旦削除してやり直してみてください。

補足

デフォルトで~/.laradock/dataが設定されていると説明しましたが、これでは他にLaradockを使ってプロジェクトを作成した際に同じ場所を参照してしまうので変えた方がいいっぽいです。ここでは詳しく解説はしませんので詳細は調べてください。

- .envの書き換え等が反映されていない可能性

コンテナを立ち上げたまま、.env等の設定を書き換えただけでは内容が反映されません。

一度、コンテナを起動させ直しましょう。再起動

$ docker-compose restartダメなら停止と削除〜起動

$ docker-compose down$ docker-compose up -d mysql nginx8. プロジェクトの起動確認

- localhostへアクセス

nginxのコンテナを立ち上がっている状態でlocalhostへアクセスします。うまくいっていれば、Laravelのトップページが表示されます。

上手くいかない場合

- Laradockの.envファイルのAPP_CODE_PATH_HOSTの設定が正しくできていない

→プロジェクトが存在するパスをちゃんと記述してあげてください。

- nginxのdefault.confのパス指定が上手くできていない

→上記に手順を記載していますので、やり直してください。

- nginxコンテナが立ち上がっていない

→docker psコマンドで確認し、立ち上がっていなければ、立ち上げてください。

ここまでくればとりあえずの環境構築は完了です!

あとは煮るなり焼くなり好きにしてください!

- 投稿日:2020-02-08T19:35:23+09:00

【docker】docker試煉日(1)

目的

熟悉與掌握docker用法,實作出內部測試環境與降低多環境需求之成本

Docker 架構

Docker 包括三個基本元素:

- 鏡像(Image):Docker 鏡像(Image),就相當於是一個 root 文件系統。比如官方鏡像 ubuntu:16.04 就包含了完整的一套 Ubuntu16.04 最小系統的 root 文件系統。

- 容器(Container):鏡像(Image)和容器(Container)的關係,就像是VM安裝概念一樣,鏡像是靜態的定義,容器是鏡像運行時的實體。容器可以被創建、啟動、停止、刪除、暫停等,隨時可依據需求啟動一個你所需要的容器(Ubuntu CentOS等)。

- 倉庫(Repository):倉庫可視為一個程式碼控制中心,用來保存鏡像。 Docker 使用客戶端-服務器 (C/S) 架構模式,使用遠端API來管理和創建Docker容器。

Docker 容器通過 Docker 鏡像來創建。

安裝方法

https://www.runoob.com/docker/centos-docker-install.html

起手式

當安裝完成docker 都要先來跑跑看是否已經能正常運行

接下來我們就開始運行我們的第一個Docker吧P-MP15:~ puwu$ docker run ubuntu:15.10 /bin/echo "Hello world" Unable to find image 'ubuntu:15.10' locally 15.10: Pulling from library/ubuntu 7dcf5a444392: Pull complete 759aa75f3cee: Pull complete 3fa871dc8a2b: Pull complete 224c42ae46e7: Pull complete Digest: sha256:02521a2d079595241c6793b2044f02eecf294034f31d6e235ac4b2b54ffc41f3 Status: Downloaded newer image for ubuntu:15.10 Hello world好的,我們今天終於完成第一項任務,可以讓我的使用docker 幫我們印出Hello world

這是多麼不容易的事情(?)接下來讓我們了解一下啟動時參數使用的用途

使用docker鏡像nginx:latest以後台模式啟動一个容器,并將容器命名為mynginx。

docker run --name mynginx -d nginx:latest使用鏡像nginx:latest以後臺模式啟動壹個容器,將容器的80端口映射到主機的80端口,主機的目錄/data映射到容器的/data

docker run -p 80:80 -v /data:/data -d nginx:latest使用鏡像nginx:latest以互動模式啟動一個容器,在容器內執行/bin/bash命令。

P-MP15:~ puwu$ docker run -it nginx:latest /bin/bash root@fecf799928e4:/#更多詳細的參數可以參考HERE

背景服務與操作可參考這篇(後續再補上)HERE

- 投稿日:2020-02-08T19:23:03+09:00

コード書いたことないPdMやPOに捧ぐ、Rails on Dockerハンズオン vol.4 - Static pages -

この記事はなにか?

この記事は私が社内のプログラミング未経験者、ビギナー向けに開催しているRuby on Rails on Dockerハンズオンの内容をまとめたものです。ていうかこの記事を基にそのままハンズオンします。ハンズオンは

1回の内容は喋りながらやると大体40~50分くらいになっています。お昼休みに有志でやっているからです。

現在進行形なので週1ペースで記事投稿していけるように頑張ります。

ビギナーの方のお役にたったり、同じように有志のハンズオンをしようとしている人の参考になれば幸いです。

他のハンズオンへのリンク

・ Vol.1 - Introduction -

・ Vol.2 - Hello, Rails on Docker -

・ Vol.3 - Scaffold, RESTful, MVC -

・ Vol.4 - Static pages -

$,#,>について

$: ローカルでコマンドを実行するときは、頭に$をつけています。

#: コンテナの中でコマンドを実行するときは、頭に#をつけています。

>: Rails console内でコマンド(Rubyプログラム)を実行するときは、頭に>をつけています。

はじめに

第4回目は、Static pages(静的なページ)を作ることにチャレンジしてみましょう!

そもそも静的なページとは、アクセスするユーザーや時間帯に関係なく同じコンテンツが表示されるページのことです。対義語は動的なページは例えばマイページのようなユーザーごとにコンテンツが変わってくるようなページのことですね。

静的なページのみで構築されているサイトを『Webサイト』、動的なページも存在するサイトを『Webアプリケーション』と呼び分けたりします。今回は、静的なトップページを作っていきますよ!

Railsの初期設定

とその前に。

今回は日本で使われ日本で運用するアプリを想定するのですが、Railsはデフォルトでは英語が使われていたりUTC(協定世界時)が使われていたりと、そのまま日本でサービス展開しようとすると面倒な部分があります。

最初にこの設定をローカライズ(日本化)しておきましょう!Timezoneの設定

Dockerfileやdocker-compose.ymlでコンテナのタイムゾーンは日本に設定していましたね(TZ=Asia/Tokyo)。Railsアプリも同じように設定してあげます。config/application.rb... class Application < Rails::Application ... config.time_zone = 'Tokyo' config.active_record.default_timezone = :local ... end

time_zoneはRailsアプリが時間を扱うときにどのtimezoneで動くかを指定する設定でデフォルトだとUTCになってます。例えばTime.currentで現在の時間を表示できたりするのですが、この結果をどのtimezoneで表示するかがこの設定で決まります。この後、Modelを保存したりするときなどもその作成日時などがこのtimezoneで設定されます。

active_record.default_timezoneはDBに書き込まれている時間をどのtimezoneとして扱うかの設定です。言語の設定

Railsではエラーメッセージなどが準備されているのですが、デフォルトでは英語で定義されています。日本でサービス展開する場合「?」となってしまうので、日本語化します。

config/application.rb... class Application < Rails::Application ... config.i18n.default_locale = :ja ... endこの設定で、

config/locales/にあるyamlファイルの中からja:で定義されている文字列が表示されるようになるんです。日本語版のファイルを作ってくださっている方がいらっしゃいますのでベースとして利用させていただきましょう。rails-i18n/ja.yml at master · svenfuchs/rails-i18n

こちらのファイルを

config/locales/ja.ymlとして保存することで日本語化完了です!ちなみに『i18n』は『internationalization』のことで『国際化』と訳されます。アクセスする国によって時間や言語を変えたりすることです(今回は日本オンリーに対応ですが...笑い)。頭の『i』とお尻の『n』の間に18文字あるので『i18n』と表現します。技術系だとこういうの最近多いっすよね?

Bootstrap

まだまだ静的なページの作成には入りませんよ!次は、Bootstrapを使えるようにしていきましょう。

BootstrapはTwitter社が開発したCSSフレームワークです。

レスポンシブデザインに標準で対応されており、CSSだけでなくJavascript(jQuery)も含まれています。

多くの人に使われているためインターネット上に情報があふれていますので初心者にも安心です。一方で、多くの人に使われているため似通ったデザインになってしまうので少し慣れてくると敬遠されがちな印象です。Boostrapをyarnでインストール

Rails5まではgemでインストールするのが主流だったと思うのですが、Rails6ではWebpackerが必須になったこともありパッケージマネージャー経由でインストールするのが主流になっていくと思われますのでその方法で。

まだコンテナを立ち上げていなかったですね。それではコンテナを立ち上げてコンテナの中でコマンドを実行していきましょう!

$ docker-compose up -d $ docker-compose exec web ash# yarn add bootstrap jquery popper.jsこれでBootstrap関連のライブラリをインストールできたのでRailsアプリで使えるように設定していきます。

まずapplication.jsでBootstrapを読み込みます。

app/javascript/packs/application.js... require("bootstrap") ...次にBootstrapをSCSSで読み込むために

application.cssをapplication.scssにリネームします。# mv app/assets/stylesheets/application.css app/assets/stylesheets/application.scssファイルの中身はCSSの記法で書かれているものなので一度全て削除して以下のように書き換えましょう。

app/assets/stylesheets/application.scss@import 'bootstrap/scss/bootstrap';最後にBootstrapと依存関係にある

jQueryとpopper.jsの設定を追加してあげます。config/webpack/environment.jsconst { environment } = require('@rails/webpack') const webpack = require('webpack') environment.plugins.append('Provide', new webpack.ProvidePlugin({ $: 'jquery', jQuery: 'jquery', Popper: ['popper.js', 'default'] })) module.exports = environmentやばいですね。たったこれだけでBootstrapの準備が整いました。Bootstrapで用意されているあらゆるスタイルシートやjavascriptが利用可能になっちゃいました。

BootstrapがどんなことができるかはBootstrap公式のDocumentationを見るのが一番いいと思っているのですが、これだけの表現が上の設定でできるようになってしまったのです。Topページを作成する

いよいよ静的なページを作っていきます。

静的なページではModelのような動的なものはいらないのでMVCのVCがあればOKですね。

VC(ルーティングも!)はrails generate controllerコマンドで作成することができます。今回はstatic_pagescontrollerでhomeactionを作ってみましょう。# rails generate controller static_pages home

rails generate controller NAME [action action]の形式でコマンドを実行できます。actionは複数指定可能です。

慣習的にNAMEは複数形を用います。このコマンドだけですでに

http://localhost:3000/static_pages/homeへのRouting, Controller#Action, Viewが出来上がっているのでアクセスできるようになっていますね。

このコマンドで作成・更新されたファイルの中身をちょっとみていきましょう!

Routing

config/routes.rbRails.application.routes.draw do get 'static_pages/home' end

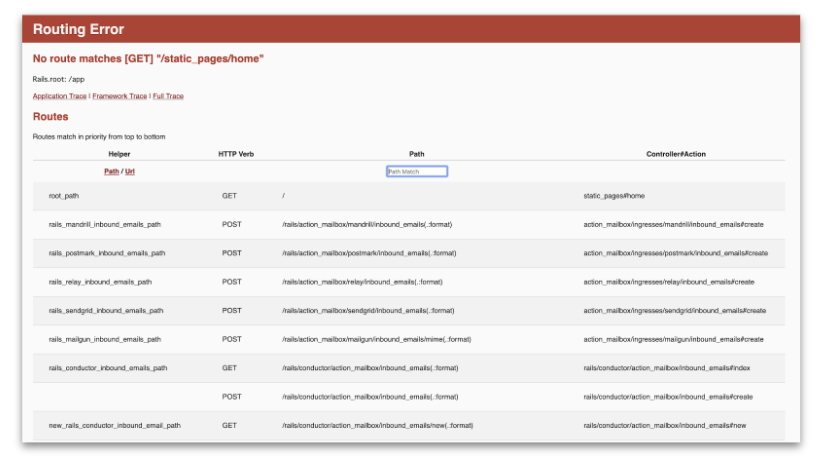

get 'static_pages/home'の行が追加されてます。前回はresoucesメソッドを使ったルーティングの指定の仕方でしたが、このように一つ一つのルートを定義することもできるのです。

これだけで「static_pages/homeのパスにgetメソッドできたリクエストをstatic_pagescontrollerのhomeactionにルーティングする」ことを定義しています。Controller

app/controllers/static_pages_controller.rbclass StaticPagesController < ApplicationController def home end end

homeアクションが定義されていますね。特段処理はないので、app/views/static_pages/home.html.erbをレンダリングするのみです。View

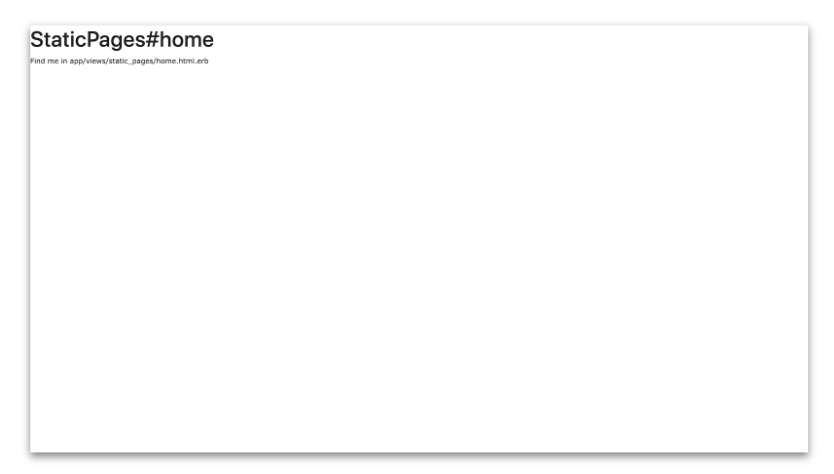

app/views/static_pages/home.html.erb<h1>StaticPages#home</h1> <p>Find me in app/views/static_pages/home.html.erb</p>

app/views/static_pages/home.html.erbファイルが生成されています。

中身も先ほどhttp://localhost:3000/static_pages/homeと同じものが表示されていることがわかりますね。ルートパスをTopページにする

現状ルートパス(

http://localhost:3000)にアクセスするとHello worldのページが表示されています。本当はこのURLにアクセスしたときにTopページを表示させたいのでルーティングの設定を更新していきます。config/routes.rbRails.application.routes.draw do root 'static_pages#home' endルートパスの設定の仕方は`root '[controller_name]#[action_name]'とするだけです!

試しに

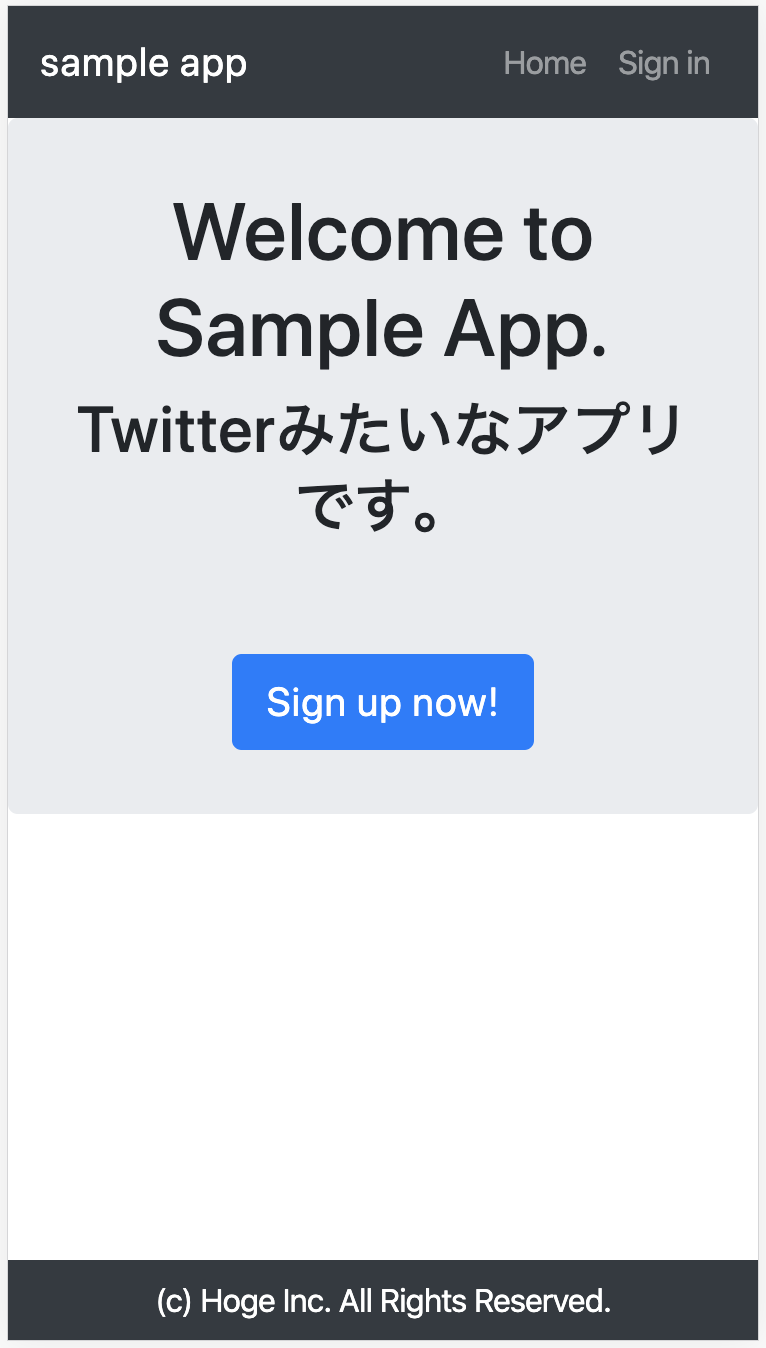

http://localhost:3000/にアクセスしてみてください。Topページが表示されるようになりましたね。

またhttp://localhost:3000/static_pages/homeにもう一度アクセスしてみましょう。get 'static_pages/home'を削除してるので以下のようにそんなルートないよとエラーになります。

Bootstrapでページを装飾する

にしても味気ないページですよね。ということでBootstrapのCSSを使いながらいい感じのページに装飾していきましょう!

CSSはHTMLのスタイル(色とか大きさとか)をまとめた変数みたいなものです。HTMLタグ(<h1>とか<p>とか)にclass属性をつけることでそのスタイルが適用されます。SCSSはCSSを書きやすくしたものです(なので本質はCSS)。

<h1 class="hoge">Hello.</h1>.hoge { font-size: 32px; color: red; }これで32pxの赤文字で"Hello."が表示されるようになるってイメージですね。

Topページのコンテンツを装飾する

ではまず、

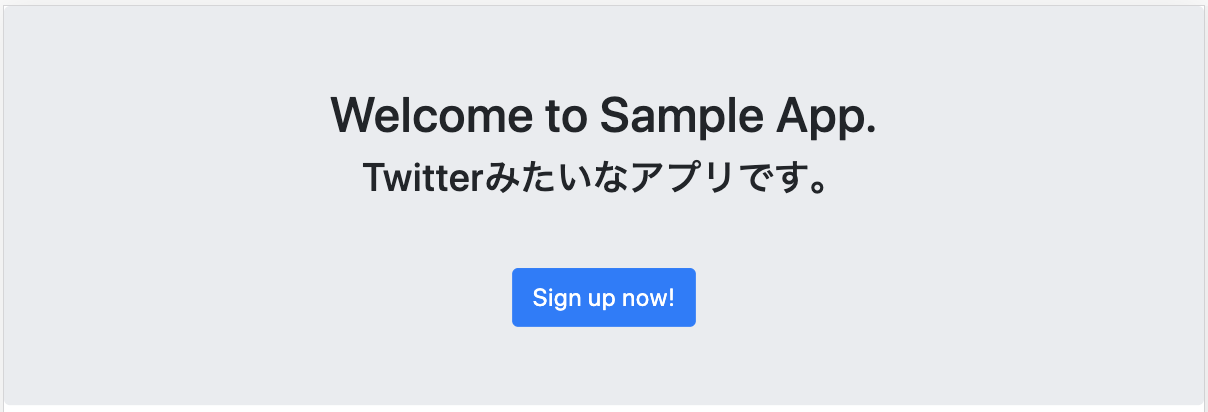

app/views/static_pages/home.html.erbを更新していい感じのTopページを作っていきましょう。app/views/static_pages/home.html.erb<div class="jumbotron mb-0"> <div class="container text-center"> <h1>Welcome to Sample App.</h1> <h2>Twitterみたいなアプリです。</h2> <%= link_to "Sign up now!", "#", class: "btn btn-lg btn-primary mt-5" %> </div> </div>ここに出てくる

jumbotron,container,text-center,btn,btn-lg,btn-primary,mt-5はすべてBootstrapのclassです。Bootstrapのclassの使い方はしっかりと公式のDocumantationがあるのでそちらをみてみましょう。実際に自分で何かを作るとなるとこういう公式ドキュメントと向き合うことが一番の近道だったりするのでここでは説明しないっす。1つだけ、ERBコードがありますね。

app/views/static_pages/home.html.erb<%= link_to "Sing up now!", "#", class: "btn btn-lg btn-primary mt-5" %>

link_toはリンクを作るためのメソッドです。HTML的にいえば<a>タグを作ってくれるということです。

link_to [表示文字], [リンク先], [options]の構文になってまして、今回の例だと以下のような<a>タグが出来上がります。<a href="#" class="btn btn-lg btn-primary mt-5">Sign up now!</a>リンク文字列やリンク先などに変数を指定でき(例えばルートパスはroot_pathが変数として割り当てられている)るのでERBファイルでリンクを作成する場合多用するコードなので覚えておきましょう。

リンク先として#を指定していますが、まだ遷移先のページを作成していないので仮置きしているだけです(#を指定しておくとリンクを押しても今いるページから遷移しないです。)編集ができたらトップページをリロードしてみましょう。以下のページになっていれば成功です!

ふへー。ぽくなってきましたね。

ただHeaderとかFooterとかも欲しくなってきました。

ヘッダーを装飾する

突然ですが、ブラウザでトップページのソースコードをみてみましょう。(右クリックで「ページのソースを表示する」を選択するとみれます。)

app/views/static_pages/home.html.erbに全く書いた記憶がないもの、例えば<head>タグとかがありますよね。Topページ<!DOCTYPE html> <html> <head> <title>App</title> <meta name="csrf-param" content="authenticity_token" /> <meta name="csrf-token" content="3702TRDf2wiVe1ErXV1NWoksR1sWw1+LO31miZuonos9K8zOmMwJ+VotF3ZXCPRP+g9IiKoZovoA8HpIjLjqmA==" /> <link rel="stylesheet" media="all" href="/assets/application.debug-9519f0a34796e622c941135a612890361ca8a44f05d715927aaa1575ce29c235.css" data-turbolinks-track="reload" /> <script src="/packs/js/application-923746675d9ea6d857bd.js" data-turbolinks-track="reload"></script> </head> <body> <div class="jumbotron"> <div class="container text-center"> <h1>Welcome to Sample App.</h1> <h2>Twitterみたいなアプリです。</h2> <a class="btn btn-lg btn-primary mt-5" href="#">Sign up now!</a> </div> </div> </body> </html>これはなんでしょう?

実はRailsアプリケーションではViewファイルの中でもLayoutと呼ばれるやつがいます。こいつはなにかというと、ページで共通な部分を表現してくれるものです。デフォルトで

app/views/layouts/application.html.erbのレイアウトファイルが利用されています。ちょっと中を覗いてみましょう。app/views/layouts/application.html.erb<!DOCTYPE html> <html> <head> <title>App</title> <%= csrf_meta_tags %> <%= csp_meta_tag %> <%= stylesheet_link_tag 'application', media: 'all', 'data-turbolinks-track': 'reload' %> <%= javascript_pack_tag 'application', 'data-turbolinks-track': 'reload' %> </head> <body> <%= yield %> </body> </html>ERBコードが入っているので少し表現は違いますが、Topページのソースコードと似た構文をしていることがわかります。実は最終的に表示されているHTMLは

app/views/static_pages/home.html.erbがこのapp/views/layouts/application.html.erbの<%= yield %>に代入されたものです。少しだけ

app/views/layouts/application.html.erbの中身をご紹介。

まず全体の構文ですが、HTMLの基本の構文が記述されていますね。<!DOCTYPE html> <html> <head> ... </head> <body> ... </body> </html>

<body>の中のyeildについては上で話した通りで、actionのviewファイルの中身が代入されるようになっています。

<head>の中はどうでしょうか?title

titleはブラウザのタブのところに表示される文字列です。今だとAppと指定されているのでそれが表示されていますね。scrf_meta_tags

CSRF(Cross-Site Request Forgery)対策のための記述です。今回のTopページではあまり活躍しませんが、POSTリクエストを飛ばすページで活躍します。簡単にいえば、正しいユーザーからのリクエストなのかというリクエストの真正性(Authenticity)を検証するために必要なことを開発者が意識せずともRailsがカバーしてくれるようになるとのこと。

csp_meta_tag

CSP(Content Security Policy)に必要なタグを生成してくれるコードです。CSPはXSS(Cross Site Scripting)を防ぐためのもので、コンテンツの提供元や取得方法を制限する手法です。別途、制限を設定することで動作するようになります。ここでは紹介程度。

stylesheet_link_tag

stylesheetの読み込み。

app/assets/stylesheets/application.css[scss]を読み込んでくれている。javascript_pack_tag

javascriptの読み込み。

app/javascript/packs/application.jsを読み込んでくれている。ってな具合です。

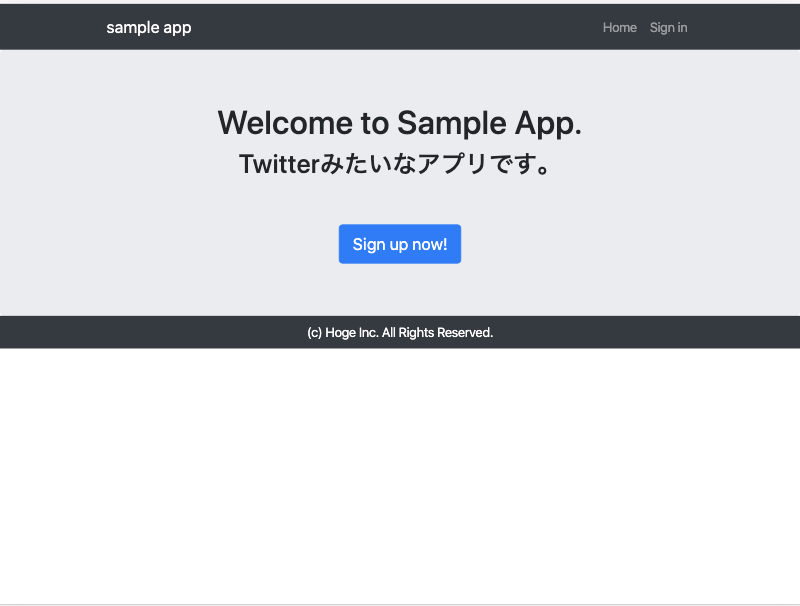

さて、長々と話してしまいましたが、本当に言いたかったことは『ヘッダーやフッターは各ページ個別のものではなく、サイトで共通のものであるはずなので、レイアウトファイルに記述するんだよ』ということです。

では、ヘッダーを

app/views/layouts/application.html.erbに記述します!app/views/layouts/application.html.erb... <body> <header class="navbar navbar-dark navbar-expand bg-dark"> <div class="container"> <%= link_to "sample app", root_path, class: "navbar-brand" %> <ul class="navbar-nav"> <li class="nav-item"><%= link_to "Home", root_path, class: "nav-link" %></li> <li class="nav-item"><%= link_to "Sign in", "#", class: "nav-link" %></li> </ul> </div> </header> <%= yield %> </body> ...このあたりもBootstrapの公式ドキュメントを参考に記述してみました => Navbar · Bootstrap

Topページにアクセスしてみましょう。以下のようになっていれば成功です!

おー、どんどんぽくなってきましたね!フッターを装飾する

最後にフッターも付けちゃいましょう!今回はコピーライトを書いているくらいのフッターをば。

フッターは

<footer>タグを使います。app/views/layouts/application.html.erb... <body> ... <%= yield %> <footer class="bg-dark"> <p class="text-center text-white py-2 mb-0">(c) Hoge Inc. All Rights Reserved.</p> </footer> </body> ...特別難しいところはありませんね。再度Topページにアクセスします。

おー、ぽい。ぽいのですが、ブラウザの下の方に余白ができているのが気になりますね...

表示するコンテンツがブラウザの縦サイズに合わない場合は、フッターは画面の最下部に表示されるようにしたい...ということで少しCSSをいじってみましょう。

app/assets/stylesheets/application.scss@import 'bootstrap/scss/bootstrap'; body { display: flex; flex-direction: column; min-height: 100vh; } footer { margin-top: auto; }本当はfooter用のファイルを作って

appliction.scssで@importする方が整理されるのでいいのですが、今回は分量も少ないのでひとまずapplication.scssに記述します。これで何をしているかというと、まず

bodyタグに対してdisplay: flex;をあててます。これはFlexboxという要素をきれいに横並びや縦並びでレイアウトしてくれるレイアウトモジュールです。

flex-direction: column;と定義しているので縦方向に要素を並べてくれます。

そして、min-height: 100vh;を定義しているのでbodyタグで囲まれた要素は最低ブラウザいっぱいの高さを持つ要素に指定されたことになります。今、

bodyタグの中にはheader,<%= yeild %>の中のdiv,footerの3つの要素が同じレベルに存在しています。これを縦方向に並べていることになるんですね。

この時、Flexboxの親要素(今回だとbody)をコンテナ、子要素(今回だとheader,div,footer)をアイテムと呼びます。

footerにはmargin-top: auto;が定義されています。これは親要素に対して、この要素の上部に最大限のmargin(余白)を付与することを表していて、簡単に言うと親要素の一番下に配置するってことになります。

今、親要素のbodyは縦に最小で100vhの高さを持ちます。コンテンツが足りない場合はbodyは100vhの高さになるのでfooterは100vhの一番下に位置します。コンテンツが100vh以上の場合はbodyもheader,div,footerの3要素の高さの合計が高さになるので、footerは自然な形でdivのすぐ下に配置されることになります。さてさて、ではTopページをリロードしてみてください!

とてもいい感じになりましたね!スマートフォンに対応する

PCだといい感じに表示されるのですが、スマートフォンだと実はとても見にくい状態になっています。ChromeのDeveloper toolsなどで確かめてみてください(Chrome DevTools での Device Mode によるモバイル端末のシミュレート)

BootstrapはもともとResponsive Design(ブラウザの横幅に合わせてCSSが変わる)に対応しているので、Viewport設定の1行を

headタグ内に挿入するだけでいい感じのデザインになります。app/views/layouts/application.html.erb... <head> ... <meta name="viewport" content="width=device-width, initial-scale=1, shrink-to-fit=no"> ... </head> ...呪文みたいな感じで書いちゃうことが多いのですが、意味は「もう逃げない。HTMLのviewportをちゃんと理解する - Qiita」の記事が参考になりました。

スマホモードでリロードしてみましょう。

文字の大きさもいい感じになりましたね。Google Fontsでフォントを変える

んー。デザインはよくなってきたけどフォントがデフォルトっぽくて気になるなぁ...

フォントはこのアプリを使うユーザーの端末にフォントがインストールされていないと使えなかったりするのであんまり冒険できないところだったりします。アプリケーションの中でフォントを配布してもいいのですが、まぁ若干面倒ですね。

そこで便利なのがGoogle Fontsです。『Webフォント』と呼ばれますが、インターネット上ですでに公開されているため端末のインストールなしで利用でき、どの端末からでも同じフォントで表現ができるようになります。

app/assets/stylesheets/application.scssでGoogle Fontsの中からNoto Sans JPをインポートしてbodyのfont-familyに指定するだけなんですね簡単です。app/assets/stylesheets/application.scss@import 'bootstrap/scss/bootstrap'; // Google Fontsから"Noto Sans JP"をインポート @import url('https://fonts.googleapis.com/css?family=Noto+Sans+JP&display=swap'); body { // "Noto Sans JP"を全体のデフォルトフォントに指定 font-family: 'Noto Sans JP', sans-serif!important; display: flex; flex-direction: column; min-height: 100vh; } footer { margin-top: auto; }少し特別な書き方として、

font-familyのところで!importantと末尾に記述してます。

!importantはCSSの適用優先度を決めるための記述で、最優先で反映させるものに使います。つまり、他にfont-familyを記述したとしてもこいつが適用されるってことです。

Bootstrapでもfont-familyを定義してくれていたりするので、こっちを最優先にするために記述してます。Google Fontsのサイトでお好きなフォントを探してみて適用してみてください!日本語フォントの場合は、『Language』で『Japanese』を選択すれば日本語フォントありに絞られます。『+』で使用フォントを追加するとインポートの仕方とかも教えてくれるので気軽に使えます。もっと詳しくはこちらの記事から↓

【2019年版】Google Fontsの使い方:初心者向けに解説!まとめ

今回は、Railsの初期設定とBootstrapのインストール、Topページのデザインをやってみました。

静的なページではありますが、コーディングした内容が反映されてどんどん変わっていくのを実感する楽しみを感じてもらえたんじゃないかと思います。次回は今回触れていなかったModelが主役です。Modelの作成からModelに用意されているメソッドを使ってデータの作成や更新を遊んでみようと思います。

では、次回も乞うご期待!ここまでお読みいただきありがとうございました!

Reference

- Ruby on Rails チュートリアル:実例を使って Rails を学ぼう

- Railsタイムゾーンまとめ - Qiita

- rails-i18n/ja.yml at master · svenfuchs/rails-i18n

- もう迷わない!CSS Flexboxの使い方を徹底解説 | Web Design Trends

- 【2019年版】Google Fontsの使い方:初心者向けに解説!

P.S. 間違っているところ、抜けているところ、説明の仕方を変えるとよりわかりやすくなるところなどありましたら、優しくアドバイスいただけると助かります。

- 投稿日:2020-02-08T17:15:07+09:00

CentOS8にDockerをインストール。名前解決できなかったのが解消した。

はじめに

さっき書いた ESXi6.7にCentOS8を最小構成で構築 の作業後に、dockerを入れたけど、dnfでこけてしまった。

pingでIP直打ちは外に通るのに、名前解決ができない。が解決したので、記録として残します。

コンテナ起動時に--net=hostをやりたくなかったので情報をさがしてみました。解決方法だけ記載

ホスト側で、NAPTの設定したら動いた。

# firewall-cmd --add-masquerade --permanent # firewall-cmd --reload前提条件

最小構成でインストールしたからでしょうか?nftablesは起動しておらず、firewalldが動作し、裏でiptablesが動いている状態でした。

nftablesは停止している。

# systemctl status nftables ● nftables.service - Netfilter Tables Loaded: loaded (/usr/lib/systemd/system/nftables.service; disabled; vendor preset: disabled) Active: inactive (dead) Docs: man:nft(8)firewalldが動いている。

# systemctl status firewalld ● firewalld.service - firewalld - dynamic firewall daemon Loaded: loaded (/usr/lib/systemd/system/firewalld.service; enabled; vendor preset: enabled) Active: active (running) since Sat 2020-02-08 16:28:47 JST; 27min ago Docs: man:firewalld(1) Main PID: 1182 (firewalld) Tasks: 2 (limit: 23585) Memory: 38.9M CGroup: /system.slice/firewalld.service mq1182 /usr/libexec/platform-python -s /usr/sbin/firewalld --nofork --nopidiptablesが動いている。

# iptables -L Chain INPUT (policy ACCEPT) target prot opt source destination Chain FORWARD (policy DROP) target prot opt source destination DOCKER-USER all -- anywhere anywhere DOCKER-ISOLATION-STAGE-1 all -- anywhere anywhere ACCEPT all -- anywhere anywhere ctstate RELATED,ESTABLISHED DOCKER all -- anywhere anywhere ACCEPT all -- anywhere anywhere ACCEPT all -- anywhere anywhere Chain OUTPUT (policy ACCEPT) target prot opt source destination Chain DOCKER (1 references) target prot opt source destination Chain DOCKER-ISOLATION-STAGE-1 (1 references) target prot opt source destination DOCKER-ISOLATION-STAGE-2 all -- anywhere anywhere RETURN all -- anywhere anywhere Chain DOCKER-ISOLATION-STAGE-2 (1 references) target prot opt source destination DROP all -- anywhere anywhere RETURN all -- anywhere anywhere Chain DOCKER-USER (1 references) target prot opt source destination RETURN all -- anywhere anywheredockerを使えるようにする

パッケージのインストール

インストール時のパッケージのバージョンではねられるので、

--nobestをつけてインストールする。# dnf config-manager --add-repo https://download.docker.com/linux/centos/docker-ce.repo # dnf install --nobest docker-ce docker-ce-cli containerd.ioサービス設定しておく

# systemctl enable docker # systemctl start dockerテストで

hello-worldを立ち上げてみる。

うまくいけば、下のように、Hello from Docker!が表示される# docker run hello-world Unable to find image 'hello-world:latest' locally latest: Pulling from library/hello-world 1b930d010525: Pull complete Digest: sha256:9572f7cdcee8591948c2963463447a53466950b3fc15a247fcad1917ca215a2f Status: Downloaded newer image for hello-world:latest Hello from Docker! This message shows that your installation appears to be working correctly. To generate this message, Docker took the following steps: 1. The Docker client contacted the Docker daemon. 2. The Docker daemon pulled the "hello-world" image from the Docker Hub. (amd64) 3. The Docker daemon created a new container from that image which runs the executable that produces the output you are currently reading. 4. The Docker daemon streamed that output to the Docker client, which sent it to your terminal. To try something more ambitious, you can run an Ubuntu container with: $ docker run -it ubuntu bash Share images, automate workflows, and more with a free Docker ID: https://hub.docker.com/ For more examples and ideas, visit: https://docs.docker.com/get-started/CentOS8のイメージで起動してみる

systemctlを動作させるために、/sbin/initで走らせないとダメぽい。# docker pull centos:centos8 # docker run --privileged -it -d --name centos8_check centos:centos8 /sbin/init # docker exec -it centos8_check /bin/bash [root@fced0781866f /]#ログインできた。

トラブル発生

名前解決できない!

コンテナ内でepelパッケージのインストールしてみようとしたら、できない。

[root@fced0781866f /]# dnf install epel-release Failed to set locale, defaulting to C.UTF-8 CentOS-8 - AppStream 0.0 B/s | 0 B 00:05 Failed to download metadata for repo 'AppStream' Error: Failed to download metadata for repo 'AppStream'コンテナ→GooglePublicDNSはIP直打ちで到達できる。

[root@fced0781866f /]# ping 8.8.8.8 PING 8.8.8.8 (8.8.8.8) 56(84) bytes of data. 64 bytes from 8.8.8.8: icmp_seq=1 ttl=52 time=5.60 msコンテナのDNSはLAN内のサーバを参照している

[root@fced0781866f /]# cat /etc/resolv.conf # Generated by NetworkManager search prosper2.net nameserver 10.254.10.241コンテナ→DNSへのpingは通る

[root@fced0781866f /]# ping 10.254.10.241 PING 10.254.10.241 (10.254.10.241) 56(84) bytes of data. 64 bytes from 10.254.10.241: icmp_seq=1 ttl=127 time=0.467 msのに、名前解決できない

[root@fced0781866f /]# ping dns.google ping: dns.google: Name or service not knownなぜだ。。。

解消できた

ホスト側で、NAPTの設定したら動いた。

# firewall-cmd --add-masquerade --permanent # firewall-cmd --reloadちゃんと

dnf install epel-releaseできた。# dnf install epel-release Failed to set locale, defaulting to C.UTF-8 CentOS-8 - AppStream 4.7 MB/s | 6.4 MB 00:01 CentOS-8 - Base 4.8 MB/s | 5.0 MB 00:01 CentOS-8 - Extras 6.2 kB/s | 2.1 kB 00:00 Dependencies resolved. =============================================================================================== Package Architecture Version Repository Size =============================================================================================== Installing: epel-release noarch 8-5.el8 extras 22 k Transaction Summary =============================================================================================== Install 1 Package Total download size: 22 k Installed size: 30 k Is this ok [y/N]: y Downloading Packages: epel-release-8-5.el8.noarch.rpm 915 kB/s | 22 kB 00:00 ----------------------------------------------------------------------------------------------- Total 36 kB/s | 22 kB 00:00 warning: /var/cache/dnf/extras-cbfb2f07b0021b7e/packages/epel-release-8-5.el8.noarch.rpm: Header V3 RSA/SHA256 Signature, key ID 8483c65d: NOKEY CentOS-8 - Extras 1.6 MB/s | 1.6 kB 00:00 Importing GPG key 0x8483C65D: Userid : "CentOS (CentOS Official Signing Key) <security@centos.org>" Fingerprint: 99DB 70FA E1D7 CE22 7FB6 4882 05B5 55B3 8483 C65D From : /etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial Is this ok [y/N]: y Key imported successfully Running transaction check Transaction check succeeded. Running transaction test Transaction test succeeded. Running transaction Preparing : 1/1 Installing : epel-release-8-5.el8.noarch 1/1 Running scriptlet: epel-release-8-5.el8.noarch 1/1 Verifying : epel-release-8-5.el8.noarch 1/1 Installed: epel-release-8-5.el8.noarch Complete!追記

インストール時に

--nobestでとりあえずは大丈夫だったけど、依存関係のエラーが出続けてしまっていた。# dnf update メタデータの期限切れの最終確認: 0:53:51 時間前の 2020年02月08日 16時38分36秒 に実施しました。 エラー: 問題: package docker-ce-3:19.03.5-3.el7.x86_64 requires containerd.io >= 1.2.2-3, but none of the providers can be installed - cannot install the best update candidate for package docker-ce-3:18.09.1-3.el7.x86_64 - package containerd.io-1.2.10-3.2.el7.x86_64 is excluded - package containerd.io-1.2.2-3.3.el7.x86_64 is excluded - package containerd.io-1.2.2-3.el7.x86_64 is excluded - package containerd.io-1.2.4-3.1.el7.x86_64 is excluded - package containerd.io-1.2.5-3.1.el7.x86_64 is excluded - package containerd.io-1.2.6-3.3.el7.x86_64 is excluded (インストール不可のパッケージをスキップするには、'--skip-broken' を追加してみてください または、'--nobest' を追加して、最適候補のパッケージのみを使用しないでください)これは嫌なので、無理やりRPMを入れてしまおう。まず、どこにあるか調べる。

# grep stable /etc/yum.repos.d/docker-ce.repo [docker-ce-stable] baseurl=https://download.docker.com/linux/centos/7/$basearch/stableそうか、そもそもCentOS7がターゲットなのか。。。

ここから拾ってこよう。# dnf update https://download.docker.com/linux/centos/7/x86_64/stable/Packages/containerd.io-1.2.10-3.2.el7.x86_64.rpm メタデータの期限切れの最終確認: 1:00:47 時間前の 2020年02月08日 16時38分36秒 に実施しました。 containerd.io-1.2.10-3.2.el7.x86_64.rpm 7.5 MB/s | 23 MB 00:03 依存関係が解決しました。 ======================================================================================================================================================================== パッケージ アーキテクチャー バージョン リポジトリー サイズ ======================================================================================================================================================================== アップグレード: containerd.io x86_64 1.2.10-3.2.el7 @commandline 23 M トランザクションの概要 ======================================================================================================================================================================== アップグレード 1 パッケージ 合計サイズ: 23 M これでよろしいですか? [y/N]: y パッケージのダウンロード: トランザクションの確認を実行中 トランザクションの確認に成功しました。 トランザクションのテストを実行中 トランザクションのテストに成功しました。 トランザクションを実行中 準備 : 1/1 scriptletの実行中: containerd.io-1.2.10-3.2.el7.x86_64 1/1 アップグレード中 : containerd.io-1.2.10-3.2.el7.x86_64 1/2 scriptletの実行中: containerd.io-1.2.10-3.2.el7.x86_64 1/2 scriptletの実行中: containerd.io-1.2.0-3.el7.x86_64 2/2 整理 : containerd.io-1.2.0-3.el7.x86_64 2/2 scriptletの実行中: containerd.io-1.2.0-3.el7.x86_64 2/2 検証 : containerd.io-1.2.10-3.2.el7.x86_64 1/2 検証 : containerd.io-1.2.0-3.el7.x86_64 2/2 アップグレード済み: containerd.io-1.2.10-3.2.el7.x86_64 完了しました!よしよし、もっかいupdateしよ。

# dnf update メタデータの期限切れの最終確認: 1:01:08 時間前の 2020年02月08日 16時38分36秒 に実施しました。 依存関係が解決しました。 ======================================================================================================================================================================== パッケージ アーキテクチャー バージョン リポジトリー サイズ ======================================================================================================================================================================== アップグレード: docker-ce x86_64 3:19.03.5-3.el7 docker-ce-stable 24 M トランザクションの概要 ======================================================================================================================================================================== アップグレード 1 パッケージ ダウンロードサイズの合計: 24 M これでよろしいですか? [y/N]: y パッケージのダウンロード: docker-ce-19.03.5-3.el7.x86_64.rpm 7.2 MB/s | 24 MB 00:03 ------------------------------------------------------------------------------------------------------------------------------------------------------------------------ 合計 7.2 MB/s | 24 MB 00:03 トランザクションの確認を実行中 トランザクションの確認に成功しました。 トランザクションのテストを実行中 トランザクションのテストに成功しました。 トランザクションを実行中 準備 : 1/1 scriptletの実行中: docker-ce-3:19.03.5-3.el7.x86_64 1/1 アップグレード中 : docker-ce-3:19.03.5-3.el7.x86_64 1/2 scriptletの実行中: docker-ce-3:19.03.5-3.el7.x86_64 1/2 scriptletの実行中: docker-ce-3:18.09.1-3.el7.x86_64 2/2 /usr/bin/dockerd は dockerd の為の互換用として設定されていません。 整理 : docker-ce-3:18.09.1-3.el7.x86_64 2/2 scriptletの実行中: docker-ce-3:18.09.1-3.el7.x86_64 2/2 検証 : docker-ce-3:19.03.5-3.el7.x86_64 1/2 検証 : docker-ce-3:18.09.1-3.el7.x86_64 2/2 アップグレード済み: docker-ce-3:19.03.5-3.el7.x86_64 完了しました!うん、大丈夫そう。

# dnf update メタデータの期限切れの最終確認: 1:01:38 時間前の 2020年02月08日 16時38分36秒 に実施しました。 依存関係が解決しました。 行うべきことはありません。 完了しました!よかった。

出典

- 投稿日:2020-02-08T15:50:56+09:00

雑に知ってしまったDockerを雑に知り直す

かわいい。Moby Dockという名前だそうです。

(くん付けかちゃん付けかで悩んで性別調べたけど出てこなかったので、ご存知の方いたらこっそり教えて下さい)TL;DR

- Dockerの存在は知っていて、コンテナ起動の方法なんかも知っている

- 自分でイメージ作成したことが無く、ちゃんとしたデバッグの手法とか知らないので改めて一から学ぶ

- k8sとかもそのうちやる

Dockerとは

星の数ほど書かれた見出しではあるものの、単語が多すぎて???ってよくなります。

解説記事眺めていて登場頻度が高めだなと感じた単語だけピックアップ。(適宜更新予定)

- 仮想化

ホスト型/ハイパーバイザ型/コンテナ型などの方式があり、Dockerはコンテナ型。他の方式との違いについては実際に触っていないのでハッキリとは言えず。解説記事を鵜呑みにするなら

- 構成のコード化。コードなので共有するためのファイルが軽い

- 処理/起動が早い

- プロセス:コンテナの比率は基本的に1:1

DBサーバとAPIサーバが必要なアプリケーションを構成する場合、他の方式だと一つの仮想環境にまとめることが多いが、コンテナ型の場合は1つのコンテナに対して1つのプロセス。よってコンテナを2つ立ち上げる。サービスの規模次第とも思うので例外はありそうだけど、これがベストプラクティスらしい。- ホストマシン

Dockerをインストールしたマシン。今この記事を書いているMacbookのこと。- Dockerエンジン

Dockerのコア。Dockerそのものっていう認識。- コンテナ

超頻出。センター英語で言うとas long asぐらい頻出。うまく言語化するのが難しいけどプロセスの実行環境みたいな。ホストマシンからは分離された独立した環境。- Dockerイメージ

これも超頻出。コンテナの設計図、なんて解説されたりもしているけど、調べてくうちに設計図兼ファイル群みたいなイメージなのかなと感じた。レイヤ構造になっていて理解するにはLinuxの知識がもっと必要だと感じたので要勉強。- Docker Hub

大量のDockerイメージが保存されたクラウド。

プログラミング言語の実行環境や、DBサーバWebサーバのイメージなどが置いてあり、ここからイメージを引っ張ってくればあっというまに環境ができあがる。インストール

※今回もmacでやってます

https://hub.docker.com/ からdmgファイル落としてきていつも通りのムーブでインストールしましょう。

前は特にアカウントとか要らなかった気がするけど、今は会員登録してダウンロードするらしい。

ちゃんと探せば会員登録しなくても落とせるリンクありそう。brewをインストールしてあるなら以下でいけるはず

$ brew install docker $ brew cask install docker使ってみる

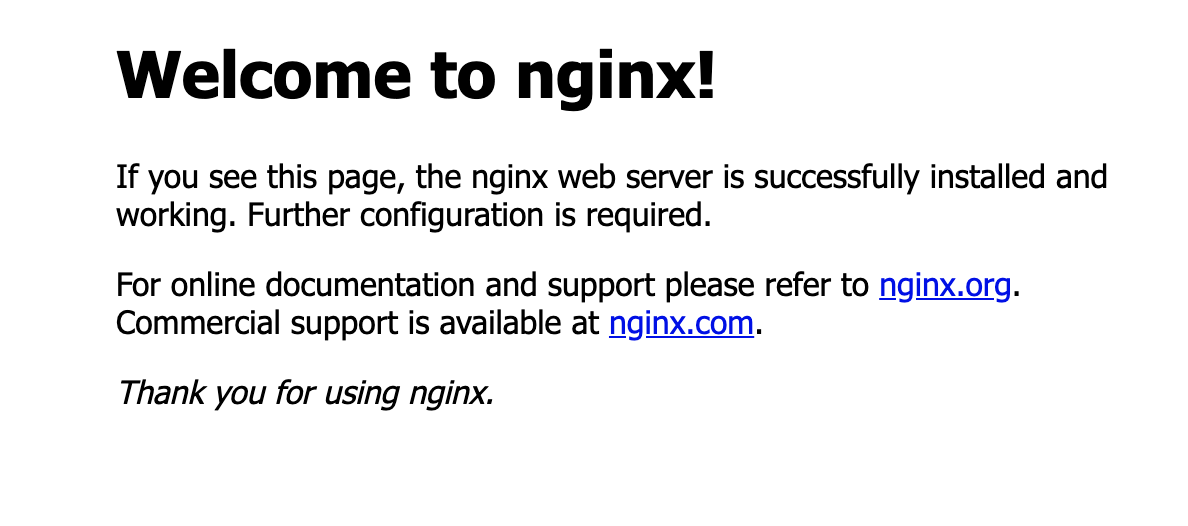

今回はnginxサーバ立ち上げてみました。

$ docker run [Dockerイメージ名] -d バックグラウンド起動 -p ポートフォワード設定 --name コンテナに名前をつける $ docker run -d -p 80:80 --name webserver nginx Unable to find image 'nginx:latest' locally # nginxっていう名前のイメージをまずローカルで探してから、Docker Hubを見に行く latest: Pulling from library/nginx bc51dd8edc1b: Pull complete 66ba67045f57: Pull complete bf317aa10aa5: Pull complete Digest: sha256:ad5552c786f128e389a0263104ae39f3d3c7895579d45ae716f528185b36bc6f Status: Downloaded newer image for nginx:latest 0d5655a34ba94e4cecad342f78e943830ea452f196ce5017464547266d6658b8http://localhost:80 へアクセス

お手軽すぎてYABAI

- 立ち上げたコンテナ情報やイメージ情報確認

$ docker images REPOSITORY TAG IMAGE ID CREATED SIZE nginx latest 2073e0bcb60e 5 days ago 127MB $ docker ps -a CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 0d5655a34ba9 nginx "nginx -g 'daemon of…" 8 minutes ago Up 8 minutes 0.0.0.0:80->80/tcp webserver

- コンテナへ接続

$ docker exec -it webserver(コンテナ名) /bin/bash root@0d5655a34ba9:/# hostname 0d5655a34ba9 # ちゃんとnginxの設定ファイルもある root@0d5655a34ba9:/# cat /etc/nginx/nginx.conf user nginx; worker_processes 1; error_log /var/log/nginx/error.log warn; pid /var/run/nginx.pid; events { worker_connections 1024; } http { include /etc/nginx/mime.types; default_type application/octet-stream; log_format main '$remote_addr - $remote_user [$time_local] "$request" ' '$status $body_bytes_sent "$http_referer" ' '"$http_user_agent" "$http_x_forwarded_for"'; access_log /var/log/nginx/access.log main; sendfile on; #tcp_nopush on; keepalive_timeout 65; #gzip on; include /etc/nginx/conf.d/*.conf; }

- コンテナ停止

$ docker stop webserver webserver $ docker container ls CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES # コンテナ停止しただけなので、イメージは残ってる $ docker images REPOSITORY TAG IMAGE ID CREATED SIZE nginx latest 2073e0bcb60e 5 days ago 127MBうんうん。

おわり

nginxはユーザ設定やパフォーマンスを少しいじったことがあるだけでインストールすらしたことありません。よくわからんけどなんか動いてる、っていうのはまさにこのこと。楽しいけど良し悪しあるなぁというのが本音です。(せっかくなのでnginxの勉強もします)

nginxコンテナを起動したわけですが、ここからの道のりはまだまだ長く。。

どうやってこの環境にアプリケーション持ち込むの?とか、

自分の好きな設定をいれたDockerイメージを作成したりとか、

コンテナはそれぞれが隔離された環境なのでコンテナ同士が通信できるようにしたりとか。

知らないといけないことは山積みなので定期的にインプット/アウトプットしていきます。今回の学び

テザリングでのpullのし過ぎには気をつけましょう。

- 投稿日:2020-02-08T15:50:56+09:00

雑に知ってしまったDockerを知り直す

かわいい。Moby Dockという名前だそうです。

(くん付けかちゃん付けかで悩んで性別調べたけど出てこなかったので、ご存知の方いたらこっそり教えて下さい)TL;DR

- Dockerの存在は知っていて、コンテナ起動の方法なんかも知っている

- 自分でイメージ作成したことが無く、ちゃんとしたデバッグの手法とか知らないので改めて一から学ぶ

- k8sとかもそのうちやる

Dockerとは

星の数ほど書かれた見出しではあるものの、単語が多すぎて???ってよくなります。

解説記事眺めていて登場頻度が高めだなと感じた単語だけピックアップ。(適宜更新予定)

- 仮想化

ホスト型/ハイパーバイザ型/コンテナ型などの方式があり、Dockerはコンテナ型。他の方式との違いについては実際に触っていないのでハッキリとは言えず。解説記事を鵜呑みにするなら

- 構成のコード化。コードなので共有するためのファイルが軽い

- 処理/起動が早い

- プロセス:コンテナの比率は基本的に1:1

DBサーバとAPIサーバが必要なアプリケーションを構成する場合、他の方式だと一つの仮想環境にまとめることが多いが、コンテナ型の場合は1つのコンテナに対して1つのプロセス。よってコンテナを2つ立ち上げる。サービスの規模次第とも思うので例外はありそうだけど、これがベストプラクティスらしい。- ホストマシン

Dockerをインストールしたマシン。今この記事を書いているMacbookのこと。- Dockerエンジン

Dockerのコア。Dockerそのものっていう認識。- コンテナ

超頻出。センター英語で言うとas long asぐらい頻出。うまく言語化するのが難しいけどプロセスの実行環境みたいな。ホストマシンからは分離された独立した環境。- Dockerイメージ

これも超頻出。コンテナの設計図、なんて解説されたりもしているけど、調べてくうちに設計図兼ファイル群みたいなイメージなのかなと感じた。レイヤ構造になっていて理解するにはLinuxの知識がもっと必要だと感じたので要勉強。- Docker Hub

大量のDockerイメージが保存されたクラウド。

プログラミング言語の実行環境や、DBサーバWebサーバのイメージなどが置いてあり、ここからイメージを引っ張ってくればあっというまに環境ができあがる。インストール

※今回もmacでやってます

https://hub.docker.com/ からdmgファイル落としてきていつも通りのムーブでインストールしましょう。

前は特にアカウントとか要らなかった気がするけど、今は会員登録してダウンロードするらしい。

ちゃんと探せば会員登録しなくても落とせるリンクありそう。brewをインストールしてあるなら以下でいけるはず

$ brew install docker $ brew cask install docker使ってみる

今回はnginxサーバ立ち上げてみました。

$ docker run [Dockerイメージ名] -d バックグラウンド起動 -p ポートフォワード設定 --name コンテナに名前をつける $ docker run -d -p 80:80 --name webserver nginx Unable to find image 'nginx:latest' locally # nginxっていう名前のイメージをまずローカルで探してから、Docker Hubを見に行く latest: Pulling from library/nginx bc51dd8edc1b: Pull complete 66ba67045f57: Pull complete bf317aa10aa5: Pull complete Digest: sha256:ad5552c786f128e389a0263104ae39f3d3c7895579d45ae716f528185b36bc6f Status: Downloaded newer image for nginx:latest 0d5655a34ba94e4cecad342f78e943830ea452f196ce5017464547266d6658b8http://localhost:80 へアクセス

お手軽すぎてYABAI

- 立ち上げたコンテナ情報やイメージ情報確認

$ docker images REPOSITORY TAG IMAGE ID CREATED SIZE nginx latest 2073e0bcb60e 5 days ago 127MB $ docker ps -a CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 0d5655a34ba9 nginx "nginx -g 'daemon of…" 8 minutes ago Up 8 minutes 0.0.0.0:80->80/tcp webserver

- コンテナへ接続

$ docker exec -it webserver(コンテナ名) /bin/bash root@0d5655a34ba9:/# hostname 0d5655a34ba9 # ちゃんとnginxの設定ファイルもある root@0d5655a34ba9:/# cat /etc/nginx/nginx.conf user nginx; worker_processes 1; error_log /var/log/nginx/error.log warn; pid /var/run/nginx.pid; events { worker_connections 1024; } http { include /etc/nginx/mime.types; default_type application/octet-stream; log_format main '$remote_addr - $remote_user [$time_local] "$request" ' '$status $body_bytes_sent "$http_referer" ' '"$http_user_agent" "$http_x_forwarded_for"'; access_log /var/log/nginx/access.log main; sendfile on; #tcp_nopush on; keepalive_timeout 65; #gzip on; include /etc/nginx/conf.d/*.conf; }

- コンテナ停止

$ docker stop webserver webserver $ docker container ls CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES # コンテナ停止しただけなので、イメージは残ってる $ docker images REPOSITORY TAG IMAGE ID CREATED SIZE nginx latest 2073e0bcb60e 5 days ago 127MBうんうん。

おわり

nginxはユーザ設定やパフォーマンスを少しいじったことがあるだけでインストールすらしたことありません。よくわからんけどなんか動いてる、っていうのはまさにこのこと。楽しいけど良し悪しあるなぁというのが本音です。(せっかくなのでnginxの勉強もします)

nginxコンテナを起動したわけですが、ここからの道のりはまだまだ長く。。

どうやってこの環境にアプリケーション持ち込むの?とか、

自分の好きな設定をいれたDockerイメージを作成したりとか、

コンテナはそれぞれが隔離された環境なのでコンテナ同士が通信できるようにしたりとか。

知らないといけないことは山積みなので定期的にインプット/アウトプットしていきます。今回の学び

テザリングでのpullのし過ぎには気をつけましょう。

- 投稿日:2020-02-08T15:40:54+09:00

SpringBoot 2.3.0 M1から入ったBuild Docker images with Cloud Native Buildpacksを試す

きっかけ

SpringBoot 2.3.0 M1がリリースされました。

https://github.com/spring-projects/spring-boot/wiki/Spring-Boot-2.3.0-M1-Release-Notes

いろいろな改善や、不要機能の削除などがされていますが、リリースノートを見ていて気になった、Build Docker images with Cloud Native Buildpacksを試してみたいと思います。

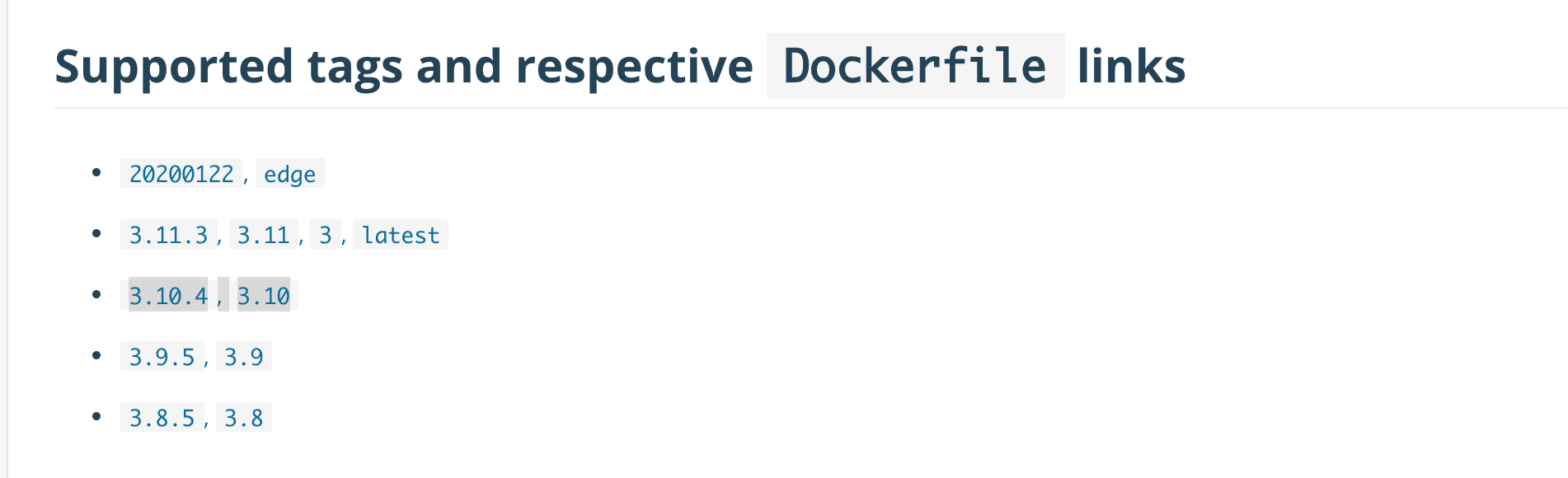

リリースノートには、以下記載がありました。

Support for building Docker images using Cloud Native Buildpacks has been added to the Maven and Gradle plugins via the spring-boot:build-image goal and the bootBuildImage task.

MavenかGradleプラグインでDockerイメージが作れるようになるようです。

早速試したいと思い、その活動のまとめとなります。How to Get Started

前回と同じ設定で

Spring Initializr でアプリ雛形を作ります。

作成後に、環境情報を取得したかったので、SpringBoot Actuatorも有効にしておきます。早速DockerImageを作ります。イメージを作成する環境ではDockerDeamonを起動しておく必要があるので、その点は注意してください。

これまでSpringBootアプリケーションをDockerImageビルドする場合は以下のステップを踏んでました。

1.mvn packageでアプリのJarファイルを作成

2. どのようなDockerImageを作るのかをDockerfileに記載

3. docker buildコマンドでイメージを作成

- Dockerfileの設定例

FROM openjdk:8-jdk-alpine ARG JAR_FILE=target/*.jar COPY ${JAR_FILE} app.jar ENTRYPOINT ["java","-jar","/app.jar"]Build Docker images with Cloud Native Buildpacksでは、上記手順を踏まずに1ステップでDockerImageまで作ることができます。

Mavenの場合は、mvn spring-boot:build-image、Gradleの場合はgradle bootBuildImageを叩くだけです。Cloud Native Buildpacksの機能で、ソースの中身を読み取ってDockerfileに設定が必要な内容を補完してくれます。$ mvn spring-boot:build-image [INFO] Scanning for projects... [INFO] [INFO] --------------------------< com.example:demo >-------------------------- [INFO] Building demo 0.0.1-SNAPSHOT [INFO] --------------------------------[ jar ]--------------------------------- [INFO] [INFO] >>> spring-boot-maven-plugin:2.3.0.M1:build-image (default-cli) > package @ demo >>> [INFO] [INFO] --- maven-resources-plugin:3.1.0:resources (default-resources) @ demo --- [INFO] Using 'UTF-8' encoding to copy filtered resources. [INFO] Copying 1 resource [INFO] Copying 0 resource [INFO] [INFO] --- maven-compiler-plugin:3.8.1:compile (default-compile) @ demo --- [INFO] Nothing to compile - all classes are up to date 中略 [INFO] > Running builder [INFO] [builder] [INFO] [builder] Cloud Foundry OpenJDK Buildpack v1.0.80 [INFO] [builder] OpenJDK JRE 11.0.5: Reusing cached layer [INFO] [builder] [INFO] [builder] Cloud Foundry JVM Application Buildpack v1.0.113 [INFO] [builder] Executable JAR: Reusing cached layer [INFO] [builder] Process types: [INFO] [builder] executable-jar: java -cp $CLASSPATH $JAVA_OPTS org.springframework.boot.loader.JarLauncher [INFO] [builder] task: java -cp $CLASSPATH $JAVA_OPTS org.springframework.boot.loader.JarLauncher [INFO] [builder] web: java -cp $CLASSPATH $JAVA_OPTS org.springframework.boot.loader.JarLauncher [INFO] [builder] [INFO] [builder] Cloud Foundry Spring Boot Buildpack v1.0.157 [INFO] [builder] Spring Boot 2.3.0.M1: Reusing cached layer [INFO] [builder] Process types: [INFO] [builder] spring-boot: java -cp $CLASSPATH $JAVA_OPTS com.example.demo.DemoApplication [INFO] [builder] task: java -cp $CLASSPATH $JAVA_OPTS com.example.demo.DemoApplication [INFO] [builder] web: java -cp $CLASSPATH $JAVA_OPTS com.example.demo.DemoApplication [INFO] [builder] [INFO] [builder] Cloud Foundry Spring Auto-reconfiguration Buildpack v1.0.159 [INFO] [builder] Spring Auto-reconfiguration 2.11.0: Reusing cached layer [INFO] [INFO] > Running exporter [INFO] [exporter] Reusing layer 'app' [INFO] [exporter] Reusing layer 'config' [INFO] [exporter] Reusing layer 'launcher' [INFO] [exporter] Reusing layer 'org.cloudfoundry.openjdk:openjdk-jre' [INFO] [exporter] Reusing layer 'org.cloudfoundry.jvmapplication:executable-jar' [INFO] [exporter] Reusing layer 'org.cloudfoundry.springboot:spring-boot' [INFO] [exporter] Reusing layer 'org.cloudfoundry.springautoreconfiguration:auto-reconfiguration' [INFO] [exporter] *** Images (89a7e99f9c15): [INFO] [exporter] docker.io/library/demo:0.0.1-SNAPSHOT [INFO] [INFO] > Running cacher [INFO] [cacher] Reusing layer 'org.cloudfoundry.openjdk:2f08c469c9a8adea1b6ee3444ba2a8242a7e99d87976a077faf037a9eb7f884b' [INFO] [cacher] Reusing layer 'org.cloudfoundry.jvmapplication:executable-jar' [INFO] [cacher] Reusing layer 'org.cloudfoundry.springboot:spring-boot' [INFO] [cacher] Reusing layer 'org.cloudfoundry.springautoreconfiguration:46ab131165317d91fd4ad3186abf755222744e2d277dc413def06f3ad45ab150' [INFO] [INFO] Successfully built image 'docker.io/library/demo:0.0.1-SNAPSHOT' [INFO] [INFO] ------------------------------------------------------------------------ [INFO] BUILD SUCCESS [INFO] ------------------------------------------------------------------------ [INFO] Total time: 01:01 min [INFO] Finished at: 2020-02-08T15:30:43+09:00 [INFO] ------------------------------------------------------------------------初回はベースイメージのダウンロードとかで時間がかかりますが、2回目以上は上記の時間ぐらいでできます。

さて、ほんとにDockerImageができているのか、確認してみましょう。

docker images REPOSITORY TAG IMAGE ID CREATED SIZE demo 0.0.1-SNAPSHOT 89a7e99f9c15 About a minute ago 226MBちゃんといますね。起動は通常のDockerImageと同じです。ここでは

docker run -it -p8080:8080 demo:0.0.1-SNAPSHOTで起動させます。docker run -it -p8080:8080 demo:0.0.1-SNAPSHOT . ____ _ __ _ _ /\\ / ___'_ __ _ _(_)_ __ __ _ \ \ \ \ ( ( )\___ | '_ | '_| | '_ \/ _` | \ \ \ \ \\/ ___)| |_)| | | | | || (_| | ) ) ) ) ' |____| .__|_| |_|_| |_\__, | / / / / =========|_|==============|___/=/_/_/_/ :: Spring Boot :: (v2.3.0.M1) 2020-02-08 06:33:43.540 WARN 1 --- [ main] pertySourceApplicationContextInitializer : Skipping 'cloud' property source addition because not in a cloud 2020-02-08 06:33:43.570 WARN 1 --- [ main] nfigurationApplicationContextInitializer : Skipping reconfiguration because not in a cloud 2020-02-08 06:33:43.635 INFO 1 --- [ main] com.example.demo.DemoApplication : Starting DemoApplication on 40fbed8bc770 with PID 1 (/workspace/BOOT-INF/classes started by cnb in /workspace) 2020-02-08 06:33:43.636 INFO 1 --- [ main] com.example.demo.DemoApplication : No active profile set, falling back to default profiles: default 2020-02-08 06:33:48.387 INFO 1 --- [ main] o.s.b.w.embedded.tomcat.TomcatWebServer : Tomcat initialized with port(s): 8080 (http) 2020-02-08 06:33:48.456 INFO 1 --- [ main] o.apache.catalina.core.StandardService : Starting service [Tomcat] 2020-02-08 06:33:48.466 INFO 1 --- [ main] org.apache.catalina.core.StandardEngine : Starting Servlet engine: [Apache Tomcat/9.0.30] 2020-02-08 06:33:48.738 INFO 1 --- [ main] o.a.c.c.C.[Tomcat].[localhost].[/] : Initializing Spring embedded WebApplicationContext 2020-02-08 06:33:48.740 INFO 1 --- [ main] o.s.web.context.ContextLoader : Root WebApplicationContext: initialization completed in 4841 ms 2020-02-08 06:33:50.208 INFO 1 --- [ main] o.s.s.concurrent.ThreadPoolTaskExecutor : Initializing ExecutorService 'applicationTaskExecutor' 2020-02-08 06:33:50.900 INFO 1 --- [ main] o.s.b.a.e.web.EndpointLinksResolver : Exposing 14 endpoint(s) beneath base path '/actuator' 2020-02-08 06:33:51.122 INFO 1 --- [ main] o.s.b.w.embedded.tomcat.TomcatWebServer : Tomcat started on port(s): 8080 (http) with context path '' 2020-02-08 06:33:51.142 INFO 1 --- [ main] com.example.demo.DemoApplication : Started DemoApplication in 9.779 seconds (JVM running for 12.428)無事、起動できています。前回アプリを使っているので、Actuatorも有効のままです。envの情報を取得してみましょう。

curl localhost:8080/actuator/env | jq % Total % Received % Xferd Average Speed Time Time Time Current Dload Upload Total Spent Left Speed 100 8753 0 8753 0 0 10130 0 --:--:-- --:--:-- --:--:-- 10130 { "activeProfiles": [], "propertySources": [ { "name": "server.ports", "properties": { "local.server.port": { "value": 8080 } } }, { "name": "servletContextInitParams", "properties": {} }, { "name": "systemProperties", "properties": { "awt.toolkit": { "value": "sun.awt.X11.XToolkit" }, "java.specification.version": { "value": "11" }, "sun.cpu.isalist": { "value": "" }, "sun.jnu.encoding": { "value": "ANSI_X3.4-1968" }, "java.class.path": { "value": "/layers/org.cloudfoundry.springautoreconfiguration/auto-reconfiguration/java-buildpack-auto-reconfiguration-2.11.0.RELEASE.jar:/workspace/BOOT-INF/classes:/workspace/BOOT-INF/lib/HdrHistogram-2.1.11.jar:/workspace/BOOT-INF/lib/LatencyUtils-2.0.3.jar:/workspace/BOOT-INF/lib/jackson-annotations-2.10.1.jar:/workspace/BOOT-INF/lib/jackson-core-2.10.1.jar:/workspace/BOOT-INF/lib/jackson-databind-2.10.1.jar:/workspace/BOOT-INF/lib/jackson-datatype-jdk8-2.10.1.jar:/workspace/BOOT-INF/lib/jackson-datatype-jsr310-2.10.1.jar:/workspace/BOOT-INF/lib/jackson-module-parameter-names-2.10.1.jar:/workspace/BOOT-INF/lib/jakarta.annotation-api-1.3.5.jar:/workspace/BOOT-INF/lib/jakarta.el-3.0.3.jar:/workspace/BOOT-INF/lib/jul-to-slf4j-1.7.29.jar:/workspace/BOOT-INF/lib/log4j-api-2.12.1.jar:/workspace/BOOT-INF/lib/log4j-to-slf4j-2.12.1.jar:/workspace/BOOT-INF/lib/logback-classic-1.2.3.jar:/workspace/BOOT-INF/lib/logback-core-1.2.3.jar:/workspace/BOOT-INF/lib/micrometer-core-1.3.3.jar:/workspace/BOOT-INF/lib/slf4j-api-1.7.29.jar:/workspace/BOOT-INF/lib/snakeyaml-1.25.jar:/workspace/BOOT-INF/lib/spring-aop-5.2.3.RELEASE.jar:/workspace/BOOT-INF/lib/spring-beans-5.2.3.RELEASE.jar:/workspace/BOOT-INF/lib/spring-boot-2.3.0.M1.jar:/workspace/BOOT-INF/lib/spring-boot-actuator-2.3.0.M1.jar:/workspace/BOOT-INF/lib/spring-boot-actuator-autoconfigure-2.3.0.M1.jar:/workspace/BOOT-INF/lib/spring-boot-autoconfigure-2.3.0.M1.jar:/workspace/BOOT-INF/lib/spring-boot-starter-2.3.0.M1.jar:/workspace/BOOT-INF/lib/spring-boot-starter-actuator-2.3.0.M1.jar:/workspace/BOOT-INF/lib/spring-boot-starter-json-2.3.0.M1.jar:/workspace/BOOT-INF/lib/spring-boot-starter-logging-2.3.0.M1.jar:/workspace/BOOT-INF/lib/spring-boot-starter-tomcat-2.3.0.M1.jar:/workspace/BOOT-INF/lib/spring-boot-starter-web-2.3.0.M1.jar:/workspace/BOOT-INF/lib/spring-context-5.2.3.RELEASE.jar:/workspace/BOOT-INF/lib/spring-core-5.2.3.RELEASE.jar:/workspace/BOOT-INF/lib/spring-expression-5.2.3.RELEASE.jar:/workspace/BOOT-INF/lib/spring-jcl-5.2.3.RELEASE.jar:/workspace/BOOT-INF/lib/spring-web-5.2.3.RELEASE.jar:/workspace/BOOT-INF/lib/spring-webmvc-5.2.3.RELEASE.jar:/workspace/BOOT-INF/lib/tomcat-embed-core-9.0.30.jar:/workspace/BOOT-INF/lib/tomcat-embed-websocket-9.0.30.jar:/workspace" }, "java.vm.vendor": { "value": "AdoptOpenJDK" }, "sun.arch.data.model": { "value": "64" }, "java.vendor.url": { "value": "https://adoptopenjdk.net/" }, "catalina.useNaming": { "value": "false" }, "user.timezone": { "value": "GMT" }, "os.name": { "value": "Linux" }, "java.vm.specification.version": { "value": "11" }, "sun.java.launcher": { "value": "SUN_STANDARD" }, "user.country": { "value": "US" }, "sun.boot.library.path": { "value": "/layers/org.cloudfoundry.openjdk/openjdk-jre/lib" }, "sun.java.command": { "value": "******" }, "jdk.debug": { "value": "release" }, "sun.cpu.endian": { "value": "little" }, "user.home": { "value": "/home/cnb" }, "user.language": { "value": "en" }, "java.specification.vendor": { "value": "Oracle Corporation" }, "java.version.date": { "value": "2019-10-15" }, "java.home": { "value": "/layers/org.cloudfoundry.openjdk/openjdk-jre" }, "file.separator": { "value": "/" }, "java.vm.compressedOopsMode": { "value": "32-bit" }, "line.separator": { "value": "\n" }, "java.specification.name": { "value": "Java Platform API Specification" }, "java.vm.specification.vendor": { "value": "Oracle Corporation" }, "java.awt.graphicsenv": { "value": "sun.awt.X11GraphicsEnvironment" }, "java.awt.headless": { "value": "true" }, "sun.management.compiler": { "value": "HotSpot 64-Bit Tiered Compilers" }, "java.runtime.version": { "value": "11.0.5+10" }, "user.name": { "value": "cnb" }, "path.separator": { "value": ":" }, "os.version": { "value": "4.9.184-linuxkit" }, "java.runtime.name": { "value": "OpenJDK Runtime Environment" }, "file.encoding": { "value": "ANSI_X3.4-1968" }, "spring.beaninfo.ignore": { "value": "true" }, "java.vm.name": { "value": "OpenJDK 64-Bit Server VM" }, "java.vendor.version": { "value": "AdoptOpenJDK" }, "java.vendor.url.bug": { "value": "https://github.com/AdoptOpenJDK/openjdk-build/issues" }, "java.io.tmpdir": { "value": "/tmp" }, "catalina.home": { "value": "/tmp/tomcat.9057283283640867778.8080" }, "java.version": { "value": "11.0.5" }, "user.dir": { "value": "/workspace" }, "os.arch": { "value": "amd64" }, "java.vm.specification.name": { "value": "Java Virtual Machine Specification" }, "PID": { "value": "1" }, "java.awt.printerjob": { "value": "sun.print.PSPrinterJob" }, "sun.os.patch.level": { "value": "unknown" }, "catalina.base": { "value": "/tmp/tomcat.9057283283640867778.8080" }, "java.library.path": { "value": "/layers/org.cloudfoundry.openjdk/openjdk-jre/lib:/usr/java/packages/lib:/usr/lib64:/lib64:/lib:/usr/lib" }, "java.vendor": { "value": "AdoptOpenJDK" }, "java.vm.info": { "value": "mixed mode" }, "java.vm.version": { "value": "11.0.5+10" }, "sun.io.unicode.encoding": { "value": "UnicodeLittle" }, "java.class.version": { "value": "55.0" } } 後略Javaの実装はAdoptOpenJDKの11が使われていますね。OSはLinuxのようです。

まとめ

Dockerfileを書かなくてもよいので、Dockerの知識がなくても簡単にDockerImageを作成できました。仕様や細かい動きを確認しないと本番へすぐ投入とはいかなそうですが、気軽にDockerImage作成できることは、メリットとなるのではないでしょうか?

使ったソースコードは以下に配置しておきました。

ご参考です。

- 投稿日:2020-02-08T15:27:11+09:00

DockerでPythonのWebアプリケーションをnginx + gunicorn で起動する

構成

- Webサーバー

- nginx

- WSGIサーバー(APサーバー)

- Gunicorn

- Webアプリケーションフレームワーク

- Django

- ここではWSGIを使用するので、WSGIに準拠していれば他のフレームワークでも良い

- この記事ではDjango固有の設定は発生しない

- WebサーバーとWSGIサーバーはDockerコンテナで稼働させる

- WebサーバーとWSGIサーバーの通信にはUNIXドメインソケットを使用する

用語の整理

WSGIサーバーとは

- WSGIとはWeb Server Gateway Interfaceのことで、WebサーバーとPythonのAPサーバー間通信のプロトコルのこと

- DjangoやFlask、Bottleなどのフレームワークもこのプロトコルに準拠している

- 上記のWSGIに則ったAPサーバーをWSGIサーバーと呼び、Gunicornはその一種

- gunicorn以外のWSGIサーバーにはuWSGIがある

UNIXドメインソケットとは

- ファイルシステムのパスを通して通信相手を探す通信方法

- そのパスにファイルが作成され、それぞれのプロセスがそのファイルにアクセスする

- 単にファイルを共有しているだけに思えるが、作成されるファイルはソケットファイルと呼ばれる特殊なファイルであり実態はない

- あくまで通信のインターフェース

構築

Gunicorn

- まずはWSGIサーバーを単体で稼働させてみる

プロジェクト作成

- Djangoをインストールする

$ pip install Django==3.0.2

- 作業環境でプロジェクトを作成する

$ django-admin.py startproject django_project .

- ここではdjango_projectという名前でプロジェクトを作成

- treeコマンドで確認すると以下のようになる

$ tree . ├── django_project │ ├── __init__.py │ ├── asgi.py │ ├── settings.py │ ├── urls.py │ └── wsgi.py ├── manage.pyGunicornコンテナ起動

- Dockerfileを作成

FROM python:3.8.0-alpine WORKDIR /usr/src/app ENV PYTHONDONTWRITEBYTECODE 1 ENV PYTHONUNBUFFERED 1 RUN pip install --upgrade pip COPY ./requirements.txt /usr/src/app/requirements.txt RUN pip install -r requirements.txt

- requirements.txt は以下の通り

requirements.txtDjango==3.0.2 gunicorn==20.0.4

- ビルドする

$ docker build -t gunicorn:tmp .

- docker-compose.yamlの記載は以下の通り

- 後でnginxの情報も追記する

version: '3.7' services: gunicorn: image: gunicorn:tmp container_name: gunicorn command: python manage.py runserver 0.0.0.0:8000 volumes: - .:/usr/src/app/ ports: - 8000:8000

python manage.py runserver 0.0.0.0:8000コマンドでテスト用簡易サーバーが起動される- ここでは稼働確認のため8000番のポートをフォワーディングしている

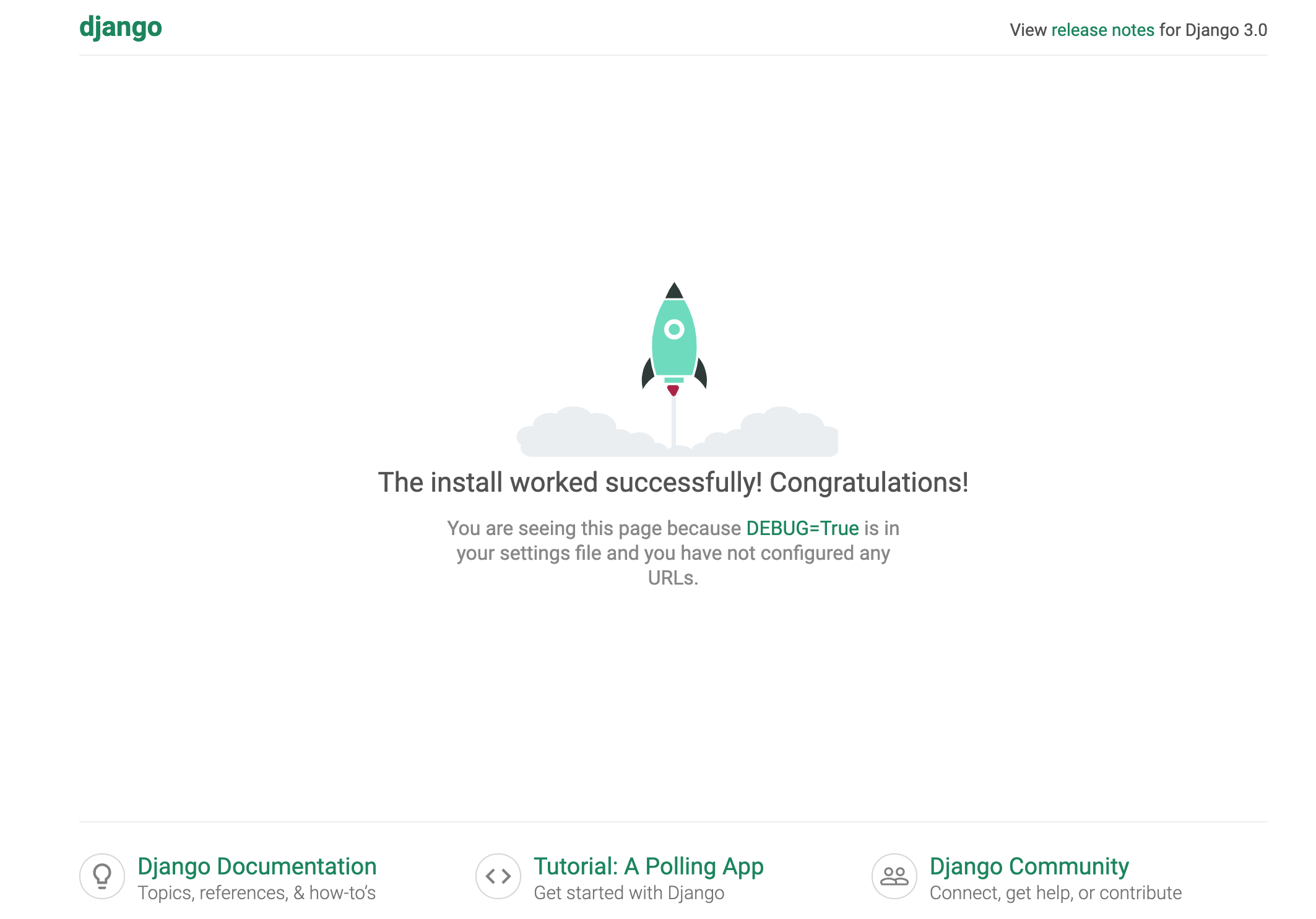

$ docker-compose up -dで起動してlocalhost:8000にアクセスしてDjangoの画面が表示されればOKNginxでUNIXドメインソケット使用する設定

- 公式のDockerイメージを使用するが、UNIXドメインソケットの設定を記載したconfファイルを作成し起動時にマウントさせる

- gunicorn.confという名前で以下の内容を記載

gunicorn.confupstream gunicorn-django { server unix:///var/run/gunicorn/gunicorn.sock; } server { listen 80; server_name localhost; location / { try_files $uri @gunicorn; } location @gunicorn { proxy_pass http://gunicorn-django; } }

upstream gunicorn-django{…}の内容がUNIXドメインソケットの設定- 記載したパスのソケットファイルを介することでgunicornと通信を行う

- つまりgunicorn側からもこのソケットファイルを呼び出す設定が必要になる

- あとはlocationのproxy_passでupstreamで指定したgunicorn-djangoを指定すればよい

- Nginxのdocker-compose.yamlの記載は以下の通り

version: '3.7' services: nginx: image: nginx:1.17.7 container_name: nginx ports: - "80:80" volumes: - ./gunicorn.conf:/etc/nginx/conf.d/default.conf

- Nginx内に

/etc/nginx/conf.d/default.confという名前でマウントする- Nginxは/etc/nginx/nginx.confを起動時に読み取り、そのファイル内で

include /etc/nginx/conf.d/*.conf;という記載がされているため、/etc/nginx/conf.d配下に自分で作成したconfファイルをマウントしておけば起動時に一緒に読み込んでくれるGunicornでUNIXドメインソケット使用する設定

- 先ほどローカルで起動させた状態から多少変更を加える

コンテナの起動コマンド

WSGIの設定

- GunicornがNginxと通信を行えるよう、以下のようなgunicornコマンドを叩く必要がある

gunicorn django_project.wsgi

- これは今回django_projectというプロジェクトを作成したときに構築されるdjango_project配下にあるwsgi.pyを読み込む

- ローカルで起動させるときはmanage.pyを起動させたが、WSGIで通信させるときはこのコマンドが必要になる

UNIXドメインソケットの設定

- UNIXドメインソケットで通信させるため、

--bindで起動時ソケットファイルのパスを指定するgunicorn django_project.wsgi --bind=unix:/var/run/gunicorn/gunicorn.sock

- これによりgunicornへのUNIXドメインソケット通信が可能になる

Doickerfile修正

- 上記の内容を基に、DockerfileのCMDを変更

DockerfileFROM python:3.8.0-alpine WORKDIR /usr/src/app ENV PYTHONDONTWRITEBYTECODE 1 ENV PYTHONUNBUFFERED 1 RUN pip install --upgrade pip COPY ./requirements.txt /usr/src/app/requirements.txt RUN pip install -r requirements.txt RUN mkdir -p /var/run/gunicorn CMD ["gunicorn", "django_project.wsgi", "--bind=unix:/var/run/gunicorn/gunicorn.sock"]

- 再度ビルドしておく

$ docker build -t gunicorn:latest .Djangoプロジェクトへアクセスできるホストを指定

- django_project配下に作成されるsetting.py内の

ALLOWED_HOSTS=[]に指定する- 本来なら制限するべきだが、ここでは全てのホストからのアクセスを許可するため

ALLOWED_HOSTS=[*]にしておく- このファイルはwsgi.pyから呼び出されている

UNIXドメインソケット通信でマウントするボリュームを作成

- Nginx、Gunicornでソケットファイルのパスを指定したので、ソケットファイルのボリュームを作成する必要がある

- 今回はDockerで起動させるので、DockerのVolumeを起動時に作成し、2つのコンテナからそのVolumeにマウントを行う

- 最終的なdocker-compose.yamlは以下の通り

docker-compose.yamlversion: '3.7' services: gunicorn: image: gunicorn:latest container_name: gunicorn volumes: - .:/usr/src/app/ - gunicorn:/var/run/gunicorn nginx: image: nginx:1.17.7 container_name: nginx depends_on: - gunicorn ports: - "80:80" volumes: - ./gunicorn.conf:/etc/nginx/conf.d/default.conf - gunicorn:/var/run/gunicorn volumes: gunicorn: driver: local

- gunicornというVolumeを作成し、それぞれのコンテナにマウントする(今回はどちらのコンテナでも

/var/run/gunicornを指定している)稼働

- 以下のコマンドで起動

$ docker-compose up -d Starting gunicorn ... done Starting nginx ... done

- 起動後に

localhostにアクセスしてみる

- 画面が表示されればOK

- 最初にGunicornを単体で稼働させたときと表示されている画面は同じだが、今回はnginxを経由して表示されている

ソースコード

- 今回作成したファイル一式はこちら

参考

- 投稿日:2020-02-08T15:27:11+09:00

DockerでPythonのWebアプリケーションをNginx + Gunicorn で起動する

構成

- Webサーバー

- nginx

- WSGIサーバー(APサーバー)

- Gunicorn

- Webアプリケーションフレームワーク

- Django

- ここではWSGIを使用するので、WSGIに準拠していれば他のフレームワークでも良い

- この記事ではDjango固有の設定は発生しない

- WebサーバーとWSGIサーバーはDockerコンテナで稼働させる

- WebサーバーとWSGIサーバーの通信にはUNIXドメインソケットを使用する

用語の整理

WSGIサーバーとは

- WSGIとはWeb Server Gateway Interfaceのことで、WebサーバーとPythonのAPサーバー間通信のプロトコルのこと

- DjangoやFlask、Bottleなどのフレームワークもこのプロトコルに準拠している

- 上記のWSGIに則ったAPサーバーをWSGIサーバーと呼び、Gunicornはその一種

- gunicorn以外のWSGIサーバーにはuWSGIがある

UNIXドメインソケットとは

- ファイルシステムのパスを通して通信相手を探す通信方法

- そのパスにファイルが作成され、それぞれのプロセスがそのファイルにアクセスする

- 単にファイルを共有しているだけに思えるが、作成されるファイルはソケットファイルと呼ばれる特殊なファイルであり実態はない

- あくまで通信のインターフェース

構築

Gunicorn

- まずはWSGIサーバーを単体で稼働させてみる

プロジェクト作成

- Djangoをインストールする

$ pip install Django==3.0.2

- 作業環境でプロジェクトを作成する

$ django-admin.py startproject django_project .

- ここではdjango_projectという名前でプロジェクトを作成

- treeコマンドで確認すると以下のようになる

$ tree . ├── django_project │ ├── __init__.py │ ├── asgi.py │ ├── settings.py │ ├── urls.py │ └── wsgi.py ├── manage.pyGunicornコンテナ起動

- Dockerfileを作成

FROM python:3.8.0-alpine WORKDIR /usr/src/app ENV PYTHONDONTWRITEBYTECODE 1 ENV PYTHONUNBUFFERED 1 RUN pip install --upgrade pip COPY ./requirements.txt /usr/src/app/requirements.txt RUN pip install -r requirements.txt

- requirements.txt は以下の通り

requirements.txtDjango==3.0.2 gunicorn==20.0.4

- ビルドする

$ docker build -t gunicorn:tmp .

- docker-compose.yamlの記載は以下の通り

- 後でnginxの情報も追記する

version: '3.7' services: gunicorn: image: gunicorn:tmp container_name: gunicorn command: python manage.py runserver 0.0.0.0:8000 volumes: - .:/usr/src/app/ ports: - 8000:8000

python manage.py runserver 0.0.0.0:8000コマンドでテスト用簡易サーバーが起動される- ここでは稼働確認のため8000番のポートをフォワーディングしている

$ docker-compose up -dで起動してlocalhost:8000にアクセスしてDjangoの画面が表示されればOKNginxでUNIXドメインソケット使用する設定

- 公式のDockerイメージを使用するが、UNIXドメインソケットの設定を記載したconfファイルを作成し起動時にマウントさせる

- gunicorn.confという名前で以下の内容を記載

gunicorn.confupstream gunicorn-django { server unix:///var/run/gunicorn/gunicorn.sock; } server { listen 80; server_name localhost; location / { try_files $uri @gunicorn; } location @gunicorn { proxy_pass http://gunicorn-django; } }

upstream gunicorn-django{…}の内容がUNIXドメインソケットの設定- 記載したパスのソケットファイルを介することでgunicornと通信を行う

- つまりgunicorn側からもこのソケットファイルを呼び出す設定が必要になる

- あとはlocationのproxy_passでupstreamで指定したgunicorn-djangoを指定すればよい

- Nginxのdocker-compose.yamlの記載は以下の通り

version: '3.7' services: nginx: image: nginx:1.17.7 container_name: nginx ports: - "80:80" volumes: - ./gunicorn.conf:/etc/nginx/conf.d/default.conf

- Nginx内に

/etc/nginx/conf.d/default.confという名前でマウントする- Nginxは/etc/nginx/nginx.confを起動時に読み取り、そのファイル内で

include /etc/nginx/conf.d/*.conf;という記載がされているため、/etc/nginx/conf.d配下に自分で作成したconfファイルをマウントしておけば起動時に一緒に読み込んでくれるGunicornでUNIXドメインソケット使用する設定

- 先ほどローカルで起動させた状態から多少変更を加える

コンテナの起動コマンド

WSGIの設定

- GunicornがNginxと通信を行えるよう、以下のようなgunicornコマンドを叩く必要がある

gunicorn django_project.wsgi

- これは今回django_projectというプロジェクトを作成したときに構築されるdjango_project配下にあるwsgi.pyを読み込む

- ローカルで起動させるときはmanage.pyを起動させたが、WSGIで通信させるときはこのコマンドが必要になる

UNIXドメインソケットの設定

- UNIXドメインソケットで通信させるため、

--bindで起動時ソケットファイルのパスを指定するgunicorn django_project.wsgi --bind=unix:/var/run/gunicorn/gunicorn.sock

- これによりgunicornへのUNIXドメインソケット通信が可能になる

Doickerfile修正

- 上記の内容を基に、DockerfileのCMDを変更

DockerfileFROM python:3.8.0-alpine WORKDIR /usr/src/app ENV PYTHONDONTWRITEBYTECODE 1 ENV PYTHONUNBUFFERED 1 RUN pip install --upgrade pip COPY ./requirements.txt /usr/src/app/requirements.txt RUN pip install -r requirements.txt RUN mkdir -p /var/run/gunicorn CMD ["gunicorn", "django_project.wsgi", "--bind=unix:/var/run/gunicorn/gunicorn.sock"]

- 再度ビルドしておく

$ docker build -t gunicorn:latest .Djangoプロジェクトへアクセスできるホストを指定

- django_project配下に作成されるsetting.py内の

ALLOWED_HOSTS=[]に指定する- 本来なら制限するべきだが、ここでは全てのホストからのアクセスを許可するため

ALLOWED_HOSTS=[*]にしておく- このファイルはwsgi.pyから呼び出されている

UNIXドメインソケット通信でマウントするボリュームを作成

- Nginx、Gunicornでソケットファイルのパスを指定したので、ソケットファイルのボリュームを作成する必要がある

- 今回はDockerで起動させるので、DockerのVolumeを起動時に作成し、2つのコンテナからそのVolumeにマウントを行う

- 最終的なdocker-compose.yamlは以下の通り

docker-compose.yamlversion: '3.7' services: gunicorn: image: gunicorn:latest container_name: gunicorn volumes: - .:/usr/src/app/ - gunicorn:/var/run/gunicorn nginx: image: nginx:1.17.7 container_name: nginx depends_on: - gunicorn ports: - "80:80" volumes: - ./gunicorn.conf:/etc/nginx/conf.d/default.conf - gunicorn:/var/run/gunicorn volumes: gunicorn: driver: local

- gunicornというVolumeを作成し、それぞれのコンテナにマウントする(今回はどちらのコンテナでも

/var/run/gunicornを指定している)稼働

- 以下のコマンドで起動

$ docker-compose up -d Starting gunicorn ... done Starting nginx ... done

- 起動後に

localhostにアクセスしてみる

- 画面が表示されればOK

- 最初にGunicornを単体で稼働させたときと表示されている画面は同じだが、今回はnginxを経由して表示されている

ソースコード

- 今回作成したファイル一式はこちら

参考

- 投稿日:2020-02-08T15:18:15+09:00

Rubyで学ぶ「ゼロから作るDeep Learning」Docker環境構築編

Dockerの環境構築

やること

- ローカルのワーキングディレクトリを作成

- DockerでRubyの環境を作成

- Dockerで作成したワーキングディレクトリをマウントして環境に入る

- Dockerに必要なパッケージ等をインストール

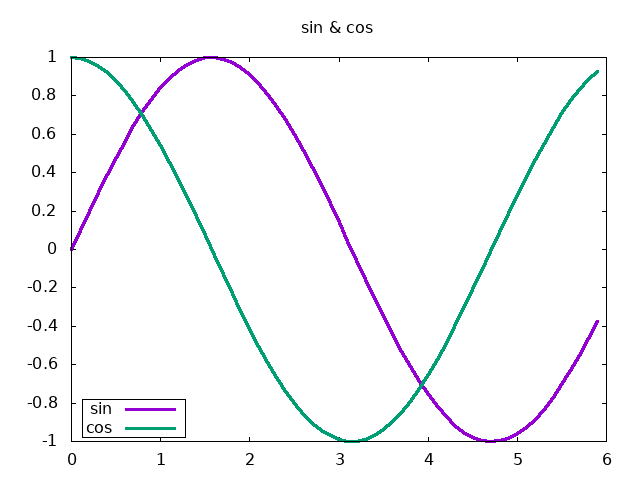

- gnuplot & numo-gnuplot

- プロット用

- numo-narray

- 行列計算 & 基礎的な数学の関数(sin cos exp等)

Docker環境を作って、ワーキングディレクトリをマウントする所まで

実行コマンド

# ローカルにワーキングディレクトリを作成 local$ mkdir working_dir # RubyのDockerイメージを取得 local$ docker pull ruby:latest # ワーキングディレクトリをマウントしてDocker環境に入る local$ docker run -v /(workingディレクトリをおいているパス)/working_dir/:/working_dir/ -it ruby /bin/bashなぜワーキングディレクトリをマウントしておくか

gnuplotで出力したファイルを、Dockerファイルシステムの外で簡単に確認できる。ローカル環境にコピーするコマンドを叩かず、手元の環境(macOS)のプレビューアプリ等で出力したpngイメージを確認できるので便利。他にも、特に設定せずに、自分のお気に入りのエディタを使えるのもよい。

Dockerに必要なパッケージ等をインストール

# gunuplotのインストール docker$ apt update -y && apt upgrade -y && apt install -y gnuplot # 各種gemのインストール docker$ gem install numo-narray numo-gnuplotとりあえず動かしてみる

ローカルのワーキングディレクトリに先人の記事のファイルをそのまま作成

Python vs Ruby 『ゼロから作るDeep Learning』 1章 sin関数とcos関数のグラフ

https://qiita.com/niwasawa/items/6d9aba43f3cdba5ca725# ワーキングディレクトリへ移動 docker$ cd working_dir # 作ったファイルがあるかの確認 docker:working_dir$ ls sin_cons.rb # ←ちゃんとローカルで作ったファイルがある # 実行 docker:working_dir$ ruby sin_cos.rb docker:working_dir$ ls ruby_graph.png sin_cons.rb # ← 出力されている結果

備考:なぜRuby?

鳥取県米子市出身で、松江にサテライトオフィスを持つ企業で働いている為。

松江といえばMatzさん、Rubyの聖地。仕事でもRubyをつかうしね。

- 投稿日:2020-02-08T15:18:15+09:00

敢えてRubyで学ぶ「ゼロから作るDeep Learning」Docker環境構築編

Dockerの環境構築

やること

- ローカルのワーキングディレクトリを作成

- DockerでRubyの環境を作成

- Dockerで作成したワーキングディレクトリをマウントして環境に入る

- Dockerに必要なパッケージ等をインストール

- gnuplot & numo-gnuplot

- プロット用

- numo-narray

- 行列計算 & 基礎的な数学の関数(sin cos exp等)

Docker環境を作って、ワーキングディレクトリをマウントする所まで

実行コマンド

# ローカルにワーキングディレクトリを作成 local$ mkdir working_dir # RubyのDockerイメージを取得 local$ docker pull ruby:latest # ワーキングディレクトリをマウントしてDocker環境に入る local$ docker run -v /(workingディレクトリをおいているパス)/working_dir/:/working_dir/ -it ruby /bin/bashなぜワーキングディレクトリをマウントしておくか

gnuplotで出力したファイルを、Dockerファイルシステムの外で簡単に確認できる。ローカル環境にコピーするコマンドを叩かず、手元の環境(macOS)のプレビューアプリ等で出力したpngイメージを確認できるので便利。他にも、特に設定せずに、自分のお気に入りのエディタを使えるのもよい。

Dockerに必要なパッケージ等をインストール

# gunuplotのインストール docker$ apt update -y && apt upgrade -y && apt install -y gnuplot # 各種gemのインストール docker$ gem install numo-narray numo-gnuplotとりあえず動かしてみる

ローカルのワーキングディレクトリに先人の記事のファイルをそのまま作成

Python vs Ruby 『ゼロから作るDeep Learning』 1章 sin関数とcos関数のグラフ

https://qiita.com/niwasawa/items/6d9aba43f3cdba5ca725# ワーキングディレクトリへ移動 docker$ cd working_dir # 作ったファイルがあるかの確認 docker:working_dir$ ls sin_cons.rb # ←ちゃんとローカルで作ったファイルがある # 実行 docker:working_dir$ ruby sin_cos.rb docker:working_dir$ ls ruby_graph.png sin_cons.rb # ← 出力されている結果

備考:なぜRuby?

鳥取県米子市出身で、松江にサテライトオフィスを持つ企業で働いている為。

松江といえばMatzさん、Rubyの聖地。仕事でもRubyをつかうしね。

- 投稿日:2020-02-08T14:07:24+09:00

RSpecにおいてActionController:RoutingError No route matches [GET] "/assets/〜"

前提

Dockerで開発

rails 5.2.1エラー内容

ActionController:RoutingError No route matches [GET] "/assets/〜"エラーが起こった状況

実装したcontrollerおよびテンプレートに対するテストを追加しようとした。

requests specについては、上記エラーは出なかった。

system specを作成しbundle exec rspecを実行すると、上記エラーが出てしまう。解決方法

config/enviroments/test.rbに以下を追加した。test.rbconfig.assets.paths << Rails.root.join('app', 'assets', 'images', 'plugins', 'rs-plugin', 'assets')エラーで出ていたassetsファイルがassets/images/plugins/rs-plugin/assetsにあるため上記コードを追加。

- 投稿日:2020-02-08T14:05:36+09:00

Docker

前回につづき、またもメモ気味な内容

前回は時間もなかったのでさくさくと書いてみた。

Dockerを始めてみよう今回はもう少しそこから進んでみる。

DockerHub

Dockerを使って環境を作成するというなら切っても切れない。

Docker Hub

指示に従い、普通に登録。Dockerイメージ

Dockerコンテナのベースになるもの。

DockerHubのExploreみるといろいろある。(ubuntu,Centos,nginx…などなど)

このDockerイメージを実行してコンテナが作成されるっぽい。

docker run <イメージ名>※ちなみにこの「run」は

docker create <イメージ名>と

docker start <イメージ名>の合わせ技みたいね。Dockerコンテナ

Dockerといえばこのコンテナ

イメージから実行された仮想環境。

起動されたコンテナは任意で停止させないと起動しっぱなしなので、用が済んだら

docker stop <イメージ名>とdocker rm <イメージ名>を入力しておくか、最初からstopかけたら削除のコマンドを入れておくなりしておこう。Dockerファイル

Dockerイメージを作成するファイル

かるく作成してみたが、なかなか慣れが必要そう。

でも、これを使えるようになるとDockerイメージを自由に構成できるし、開発環境も統一出来そうっすね。いいね。

でも難しそう…おい、楽しいぞDocker

触ってみると難しいことは今のところはまだなさそう。

コンテナとかイメージをちゃんと説明できそうもないが実際にアプリ作れるようになるともう少し理解が進むかも。

- 投稿日:2020-02-08T14:05:36+09:00

Dockerを始めてみよう その2

前回につづき、またもメモ気味な内容

前回は時間もなかったのでさくさくと書いてみた。

Dockerを始めてみよう今回はもう少しそこから進んでみる。

DockerHub

Dockerを使って環境を作成するというなら切っても切れない。

Docker Hub

指示に従い、普通に登録。Dockerイメージ

Dockerコンテナのベースになるもの。

DockerHubのExploreみるといろいろある。(ubuntu,Centos,nginx…などなど)

このDockerイメージを実行してコンテナが作成されるっぽい。

docker run <イメージ名>※ちなみにこの「run」は

docker create <イメージ名>と

docker start <イメージ名>の合わせ技みたいね。Dockerコンテナ

Dockerといえばこのコンテナ

イメージから実行された仮想環境。

起動されたコンテナは任意で停止させないと起動しっぱなしなので、用が済んだら

docker stop <イメージ名>とdocker rm <イメージ名>を入力しておくか、最初からstopかけたら削除のコマンドを入れておくなりしておこう。Dockerファイル

Dockerイメージを作成するファイル

かるく作成してみたが、なかなか慣れが必要そう。

でも、これを使えるようになるとDockerイメージを自由に構成できるし、開発環境も統一出来そうっすね。いいね。

でも難しそう…おい、楽しいぞDocker

触ってみると難しいことは今のところはまだなさそう。

コンテナとかイメージをちゃんと説明できそうもないが実際にアプリ作れるようになるともう少し理解が進むかも。

- 投稿日:2020-02-08T13:25:32+09:00

Dockerを使ったLaravelの環境構築

はじめに

最近は現場でも、Docker環境下でLaravleを触ることが増えて少しは知見も溜まってきたかと思いますので、忘れないように忘備録として残しておきます

ここでは、

dockerやdocker-composeのインストールに関しては触れませんので、まだの方はこちらの記事がわかりやすかったので参考にしてみてください記事内の不備や、もっとこうした方がいいいよというアドバイスがございましたらコメントお願いします

構成

任意のディレクトリに

SampleProjectを作成して下記のディテクトり構成で環境を構築しますSampleProject ├── docker-compose.yml ├── docker │ ├── php │ │ ├── Dockfile │ │ └── php.ini │ └── nginx │ └── default.conf └── src └── Laravelのプロジェクトファイルdocker-compose.ymlの中身

docker-compose.ymlは複数のコンテナを同時に動かすためのツールである、Docker Composeを利用するために使用するYAMLファイルですdocker-compose.ymlversion: '3' services: php: container_name: php-1 build: ./docker/php volumes: - ./src:/var/www nginx: image: nginx container_name: nginx-1 ports: - 80:80 volumes: - ./src:/var/www - ./docker/nginx/default.conf:/etc/nginx/conf.d/default.conf depends_on: - php db: image: mysql:5.7 container_name: db-host-1 environment: MYSQL_ROOT_PASSWORD: root MYSQL_DATABASE: sample_project MYSQL_USER: docker MYSQL_PASSWORD: docker TZ: 'Asia/Tokyo' command: mysqld --character-set-server=utf8mb4 --collation-server=utf8mb4_unicode_ci volumes: - ./docker/db/data:/var/lib/mysql - ./docker/db/my.cnf:/etc/mysql/conf.d/my.cnf - ./docker/db/sql:/docker-entrypoint-initdb.d ports: - 3306:3306 node: image: node:12.13-alpine tty: true volumes: - ./src:/var/www working_dir: /var/wwwDockerfileの中身

DockerfileとはDocker上で動作させるコンテナの構成情報を記述するためのファイルですFROM php:7.2-fpm COPY php.ini /usr/local/etc/php/ RUN apt-get update \ && apt-get install -y zlib1g-dev mariadb-client \ && docker-php-ext-install zip pdo_mysql #Composer install RUN php -r "copy('https://getcomposer.org/installer', 'composer-setup.php');" RUN php composer-setup.php RUN php -r "unlink('composer-setup.php');" RUN mv composer.phar /usr/local/bin/composer ENV COMPOSER_ALLOW_SUPERUSER 1 ENV COMPOSER_HOME /composer ENV PATH $PATH:/composer/vendor/bin WORKDIR /var/www RUN composer global require "laravel/installer"php.iniの中身

php.ini[Date] date.timezone = "Asia/Tokyo" [mbstring] mbstring.internal_encoding = "UTF-8" mbstring.language = "Japanese"default.confの中身

default.confはngninxの設定情報を記述するためのファイルですdefault.confserver { listen 80; index index.php index.html; root /var/www/public; location / { try_files $uri $uri/ /index.php?$query_string; } location ~ \.php$ { fastcgi_split_path_info ^(.+\.php)(/.+)$; fastcgi_pass php:9000; fastcgi_index index.php; include fastcgi_params; fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name; fastcgi_param PATH_INFO $fastcgi_path_info; } }環境構築の手順

はじめに任意の場所に

SampleProjectを作成する~/ $ mkdir SampleProject

docker-compose.ymlファイルを作成して、中身は冒頭で紹介したdocker-compose.ymlの内容をコピペする~/SampleProject $ touch docker-compose.yml