- 投稿日:2019-12-09T23:57:52+09:00

Amazon SageMaker 物体検出モデルの構築 ~Honey Bees~

Amazon AI by ナレコム Advent Calendar 2019の8日目の記事です。

AWS公式機械学習トレーニングの Amazon SageMaker: Build an Object Detection Model Using Images Labeled with Ground Truth (Japanese) (Ground Truth のラベルが付いたイメージを使用して、オブジェクト検出モデルを構築) を参考に、物体検出のモデル構築についてまとめてみました。

物体検出とは

今回は画像からミツバチの検出を行います。

クラスタリング(分類)・・・1枚の画像がどのタグに分類できるか

物体検出・・・1枚の画像の中から特定の物体の境界ボックス(BoundingBox)を検出

セグメンテーション・・・ピクセル単位での分類データのダウンロード

iNaturalist.org から CC0 ライセンスに基づくミツバチの画像500枚を使用します。

ここからダウンロードしてください。学習画像500枚、テスト画像10枚、アノテーションデータ(.manifest)で構成されています。

ラベリングの実施

output.manifest は GroundTruth を使ってラベリングされた結果です。

各行が各学習画像のアノテーション結果になっています。{"source-ref":"s3://sagemaker-remars/datasets/na-bees/500/10006450.jpg","bees-500":{"annotations":[{"class_id":0,"width":95.39999999999998,"top":256.2,"height":86.80000000000001,"left":177}],"image_size":[{"width":500,"depth":3,"height":500}]},"bees-500-metadata":{"job-name":"labeling-job/bees-500","class-map":{"0":"bee"},"human-annotated":"yes","objects":[{"confidence":0.75}],"creation-date":"2019-05-16T00:15:58.914553","type":"groundtruth/object-detection"}} {"source-ref":"s3://sagemaker-remars/datasets/na-bees/500/10022723.jpg","bees-500":{"annotations":[{"class_id":0,"width":93.8,"top":228.8,"height":135,"left":126.8}],"image_size":[{"width":375,"depth":3,"height":500}]},"bees-500-metadata":{"job-name":"labeling-job/bees-500","class-map":{"0":"bee"},"human-annotated":"yes","objects":[{"confidence":0.82}],"creation-date":"2019-05-16T00:41:33.384412","type":"groundtruth/object-detection"}} {"source-ref":"s3://sagemaker-remars/datasets/na-bees/500/10059108.jpg","bees-500":{"annotations":[{"class_id":0,"width":157.39999999999998,"top":188.60000000000002,"height":131.2,"left":110.8}],"image_size":[{"width":375,"depth":3,"height":500}]},"bees-500-metadata":{"job-name":"labeling-job/bees-500","class-map":{"0":"bee"},"human-annotated":"yes","objects":[{"confidence":0.8}],"creation-date":"2019-05-16T00:57:28.636681","type":"groundtruth/object-detection"}} ・・・output.manifestを編集するか、ラベリングツールは好きなもの(VoTTなど)を使用し、下記のようなをフォーマットでアノテーションデータを作成します。

{"source-ref": "s3://{bucketname}/{foldername}/train/{root}.{exts}", "train/validation": {"annotations": [{"class_id": {class_id}, "width": {width}, "top": {top}, "height": {height}, "left": {left}}], "image_size": [{"width": {width}, "depth": {depth}, "height": {height}}]}}

- "source-ref":画像のS3パス

- "train/validation":学習(Train)もしくは検証(Validation)

- "annotations":アノテーションデータ

- "class_id":検出するタグ(タグごとに0から順につける番号)

- "width", "top", "height", "left":タグの境界ボックスの左上の点(top, left)とボックスのサイズ(width, height)

- "image_size":画像幅(width)、チャンネル数(depth)、画像高さ(height)

今回は学習画像(Train)を400枚、残りの100枚を検証画像(Validation)とし、train.manifest、validation.manifest の2つを作成します。対応する画像のファイル形式はJPGとPNGになります。

train.manifest

{"source-ref": "s3://sagemaker-mlbees/20191208/train/10006450.jpg", "train": {"annotations": [{"class_id": 0, "width": 95, "top": 256, "height": 86, "left": 177}], "image_size": [{"width": 500, "depth": 3, "height": 500}]}} {"source-ref": "s3://sagemaker-mlbees/20191208/train/10022723.jpg", "train": {"annotations": [{"class_id": 0, "width": 93, "top": 228, "height": 135, "left": 126}], "image_size": [{"width": 375, "depth": 3, "height": 500}]}} {"source-ref": "s3://sagemaker-mlbees/20191208/train/10059108.jpg", "train": {"annotations": [{"class_id": 0, "width": 157, "top": 188, "height": 131, "left": 110}], "image_size": [{"width": 375, "depth": 3, "height": 500}]}} ・・・ {"source-ref": "s3://sagemaker-mlbees/20191208/train/10437385.jpg", "train": {"annotations": [{"class_id": 0, "width": 38, "top": 306, "height": 31, "left": 73}, {"class_id": 0, "width": 40, "top": 281, "height": 24, "left": 214}, {"class_id": 0, "width": 37, "top": 283, "height": 24, "left": 281}, {"class_id": 0, "width": 40, "top": 236, "height": 26, "left": 360}, {"class_id": 0, "width": 25, "top": 192, "height": 24, "left": 300}, {"class_id": 0, "width": 36, "top": 193, "height": 29, "left": 144}, {"class_id": 0, "width": 19, "top": 146, "height": 23, "left": 224}, {"class_id": 0, "width": 20, "top": 105, "height": 23, "left": 418}, {"class_id": 0, "width": 30, "top": 340, "height": 29, "left": 20}, {"class_id": 0, "width": 27, "top": 162, "height": 18, "left": 211}, {"class_id": 0, "width": 20, "top": 104, "height": 23, "left": 226}, {"class_id": 0, "width": 34, "top": 208, "height": 38, "left": 451}, {"class_id": 0, "width": 35, "top": 331, "height": 24, "left": 52}, {"class_id": 0, "width": 37, "top": 278, "height": 25, "left": 312}, {"class_id": 0, "width": 31, "top": 171, "height": 17, "left": 175}, {"class_id": 0, "width": 26, "top": 152, "height": 16, "left": 177}, {"class_id": 0, "width": 15, "top": 166, "height": 24, "left": 375}, {"class_id": 0, "width": 25, "top": 177, "height": 17, "left": 408}, {"class_id": 0, "width": 22, "top": 160, "height": 18, "left": 395}, {"class_id": 0, "width": 20, "top": 126, "height": 16, "left": 375}, {"class_id": 0, "width": 17, "top": 141, "height": 17, "left": 319}, {"class_id": 0, "width": 16, "top": 135, "height": 17, "left": 349}, {"class_id": 0, "width": 17, "top": 137, "height": 17, "left": 302}, {"class_id": 0, "width": 18, "top": 135, "height": 19, "left": 279}, {"class_id": 0, "width": 26, "top": 101, "height": 22, "left": 470}, {"class_id": 0, "width": 19, "top": 78, "height": 13, "left": 397}, {"class_id": 0, "width": 15, "top": 96, "height": 18, "left": 366}, {"class_id": 0, "width": 21, "top": 101, "height": 19, "left": 171}, {"class_id": 0, "width": 21, "top": 47, "height": 17, "left": 173}, {"class_id": 0, "width": 11, "top": 54, "height": 15, "left": 232}, {"class_id": 0, "width": 16, "top": 66, "height": 13, "left": 241}, {"class_id": 0, "width": 23, "top": 89, "height": 17, "left": 244}, {"class_id": 0, "width": 13, "top": 80, "height": 18, "left": 275}, {"class_id": 0, "width": 19, "top": 74, "height": 14, "left": 329}, {"class_id": 0, "width": 17, "top": 76, "height": 14, "left": 365}, {"class_id": 0, "width": 18, "top": 80, "height": 17, "left": 312}, {"class_id": 0, "width": 15, "top": 22, "height": 25, "left": 401}, {"class_id": 0, "width": 19, "top": 39, "height": 17, "left": 347}, {"class_id": 0, "width": 16, "top": 42, "height": 15, "left": 309}, {"class_id": 0, "width": 16, "top": 53, "height": 12, "left": 281}, {"class_id": 0, "width": 15, "top": 59, "height": 14, "left": 284}, {"class_id": 0, "width": 12, "top": 20, "height": 15, "left": 181},validation.manifest

validation.manifest は "train" の部分を "validation" に置換してください。{"source-ref": "s3://sagemaker-mlbees/20191208/train/6381998.jpg", "validation": {"annotations": [{"class_id": 0, "width": 215, "top": 70, "height": 196, "left": 104}], "image_size": [{"width": 416, "depth": 3, "height": 369}]}} {"source-ref": "s3://sagemaker-mlbees/20191208/train/6415127.jpg", "validation": {"annotations": [{"class_id": 0, "width": 121, "top": 94, "height": 100, "left": 73}], "image_size": [{"width": 484, "depth": 3, "height": 500}]}} {"source-ref": "s3://sagemaker-mlbees/20191208/train/6415462.jpg", "validation": {"annotations": [{"class_id": 0, "width": 52, "top": 187, "height": 56, "left": 71}, {"class_id": 0, "width": 50, "top": 173, "height": 59, "left": 197}, {"class_id": 0, "width": 65, "top": 316, "height": 48, "left": 363}, {"class_id": 0, "width": 66, "top": 112, "height": 45, "left": 244}], "image_size": [{"width": 500, "depth": 3, "height": 452}]}}アノテーションデータに指定したS3のパス(この例では s3://sagemaker-mlbees/20191208/train/ )へ500枚の学習および検証画像をアップロードします。

s3://sagemaker-mlbees/20191208/ へアノテーションデータ( train.manifest, validation.manifest )をアップロードします。

次のトレーニングジョブ作成時にこれらのパスを使うのでメモっておいてください。モデルをトレーニングしてデプロイする

トレーニングジョブの作成

SageMaker を開き、トレーニングジョブを作成します。

ジョブ設定

ジョブ名 mlbees-20191208 IAMロール 新しいロールの作成(AmazonSageMaker-ExecutionRole-20191208Txxxxxx) アルゴリズムのソース AmazonSageMaker組み込みアルゴリズム アルゴリズムの選択 ObjectDetection コンテナ 825641698319.dkr.ecr.us-east-2.amazonaws.com/object-detection:1 入力モード Pipe インスタンスタイプ ml.p2.xlarge インスタンス数 1 インスタンスあたりの追加のストレージボリューム(GB) 50 最大ランタイム 360000 seconds ネットワーク

ネットワーク分離の有効化 false ハイパーパラメータ

base_network resnet-50 use_pretrained_model 1 num_classes 1 epochs 30 larning_rate 0.001 lr_scheduler_factor 0.1 optimizer sgd momentum 0.9 weight_decay 0.0005 mini_batch_size 8 image_shape 300 label_width 350 num_training_samples 400 nms_threshold 0.45 overlap_threshold 0.5 freeze_layer_pattern false early_stopping false early_stopping_min_epochs 10 early_stopping_patience 5 early_stopping_tolerance 0.0 入力データ設定

train

チャンネル名 train 入力モードオプション Pipe コンテンツタイプ application/x-recordio 圧縮タイプ None レコードラッパー RecordIO Data source S3 S3データタイプ AugmentedManifestFile S3データディストリビューションタイプ FullyReplicated AugmentedManifestFile 属性名 (パイプ入力モード必須) source-ref, train S3の場所 s3://sagemaker-mlbees/20191208/train.manifest validation

チャンネル名 validation 入力モードオプション Pipe コンテンツタイプ application/x-recordio 圧縮タイプ None レコードラッパー RecordIO Data source S3 S3データタイプ AugmentedManifestFile S3データディストリビューションタイプ FullyReplicated AugmentedManifestFile 属性名 (パイプ入力モード必須) source-ref, validation S3の場所 s3://sagemaker-mlbees/20191208/validation.manifest 出力データ設定

S3出力パス s3://sagemaker-mlbees/20191208/ マネージド型スポットのトレーニング

マネージド型スポットトレーニングの有効化 True ジョブが終了するまでの最大待機時間 オプション停止条件 360000 seconds トレーニングジョブがInProgressからCompletedになったら学習が完了です。

モデルの作成

モデルを作成します。

モデル設定

モデル名 mlbees-20191208 IAMロール トレーニングジョブと同じもの コンテナの定義1

コンテナ入力オプション モデルアーティファクトと推論イメージの場所を指定します。 モデルアーティファクトと推論イメージの場所を指定します。 単一のモデルを使用する 推論コードイメージの場所 825641698319.dkr.ecr.us-east-2.amazonaws.com/object-detection:1 アーティファクトの場所 s3://sagemaker-mlbees/20191208/mlbees-20191208/output/model.tar.gz ネットワーク

ネットワーク分離の有効化 False エンドポイントの作成と設定

エンドポイント設定を作成します。

Endpoint

エンドポイント名 mlbees-20191208 エンドポイント設定のアタッチ

新しいエンドポイント設定の作成 新しいエンドポイント設定

エンドポイント設定名 mlbees-20191208 エンドポイント設定の作成が完了したら、エンドポイントを作成します。

Creating からInService になったら使えます。推論

作成したエンドポイントを用いてテスト画像を推論します。

AWS CLIを設定して、下記のPythonコードを実行しましょう!import boto3 import json with open("dataset/test/22971237.jpg", "rb") as f: image = f.read() response = boto3.client('sagemaker-runtime').invoke_endpoint( EndpointName="mlbees-20191208", Body=image, ContentType='image/jpeg' ) predictions = json.loads(response['Body'].read()) print(predictions)推論結果は、(class_id, score, xmin, ymin, xmax, ymax)の順で格納されており、それぞれ

class_id:タグID

score:推論スコア

xmin:境界ボックスの左上のx値(※画像サイズで正規化してあるので注意)

ymin:境界ボックスの左上のy値(※画像サイズで正規化してあるので注意)

xmax:境界ボックスの右下のx値(※画像サイズで正規化してあるので注意)

ymax:境界ボックスの右下のy値 (※画像サイズで正規化してあるので注意)

になっています{'prediction': [[0.0, 0.4678894877433777, 0.30429762601852417, 0.24999865889549255, 0.6138879060745239, 0.6268823146820068], [0.0, 0.42358464002609253, 0.06584984064102173, 0.06060954928398132, 0.9343515038490295, 0.9401313066482544], [0.0, 0.41352295875549316, 0.30878573656082153, 0.10083526372909546, 0.6731508374214172, 0.5129770636558533], [0.0, 0.39709046483039856, 0.33817505836486816, 0.4873414635658264, 0.6675703525543213, 0.9277041554450989], [0.0, 0.378907710313797, 0.0, 0.0, 0.3687918484210968, 0.5197888016700745], [0.0, 0.37673383951187134, 0.07746218144893646, 0.0, 0.5161272287368774, 0.3293883800506592], [0.0, 0.3741675913333893, 0.0, 0.460550993680954, 0.36986619234085083, 1.0], [0.0, 0.37143221497535706, 0.5950260162353516, 0.0, 1.0, 0.21253566443920135], [0.0, 0.3708018660545349, 0.3493179380893707, 0.0, 1.0, 0.6512178182601929], [0.0, 0.3700588643550873, 0.27566099166870117, 0.0, 0.713475227355957, 0.3211899995803833], [0.0, 0.3692185580730438, 0.39444130659103394, 0.3983367681503296, 1.0, 1.0], [0.0, 0.36762967705726624, 0.2224271595478058, 0.21391180157661438, 0.7647933959960938, 0.7966573238372803], [0.0, 0.3665901720523834, 0.0, 0.31598204374313354, 0.5442211627960205, 0.7052187323570251], [0.0, 0.36615416407585144, 0.0, 0.7466477751731873, 0.3294963836669922, 1.0], [0.0, 0.3645714223384857, 0.78152996301651, 0.0, 1.0, 0.38953807950019836], [0.0, 0.3632708489894867, 0.6367571353912354, 0.14908206462860107, 1.0, 0.8790770769119263], [0.0, 0.3581337630748749, 0.0, 0.7736784815788269, 0.11148740351200104, 1.0], [0.0, 0.35730576515197754, 0.18405702710151672, 0.5357580184936523, 0.8030450344085693, 1.0], [0.0, 0.35632744431495667, 0.4812198281288147, 0.0, 0.9089540839195251, 0.32849448919296265], [0.0, 0.35606932640075684, 0.4814307987689972, 0.3763745427131653, 0.6160391569137573, 0.5194752216339111], [0.0, 0.35529276728630066, 0.0, 0.0, 0.08277034014463425, 0.051912762224674225], [0.0, 0.35219448804855347, 0.5505965352058411, 0.33695971965789795, 0.7397928833961487, 0.5715459585189819], [0.0, 0.3487113118171692, 0.42075949907302856, 0.844500720500946, 0.47111785411834717, 0.8974922299385071], [0.0, 0.3482074737548828, 0.0, 0.0, 0.3503129482269287, 0.24298378825187683], [0.0, 0.3474455773830414, 0.5203220844268799, 0.2931615710258484, 0.8834731578826904, 0.7036521434783936], [0.0, 0.3472687304019928, 0.0, 0.0, 0.10882196575403214, 0.22120940685272217], [0.0, 0.3466414511203766, 0.4666988253593445, 0.6249315142631531, 0.5282527804374695, 0.6908530592918396], [0.0, 0.3453116714954376, 0.31746411323547363, 0.8423987627029419, 0.3688467741012573, 0.8994448184967041], [0.0, 0.3440929353237152, 0.7796421647071838, 0.6209114789962769, 1.0, 1.0], [0.0, 0.34316927194595337, 0.6643545031547546, 0.0558457225561142, 1.0, 0.535685122013092], [0.0, 0.3427833914756775, 0.544445812702179, 0.08242097496986389, 0.8637402653694153, 0.5203053951263428], [0.0, 0.3418370485305786, 0.0, 0.6646335124969482, 0.6075617074966431, 0.987572431564331], [0.0, 0.341707706451416, 0.07544617354869843, 0.1437387317419052, 0.5128083229064941, 0.4533810019493103], [0.0, 0.3399723768234253, 0.5327222943305969, 0.4944736957550049, 0.8722519278526306, 0.9193394184112549], [0.0, 0.3384418189525604, 0.35905712842941284, 0.4564792513847351, 0.5525619983673096, 0.6246435046195984], [0.0, 0.33811572194099426, 0.0, 0.8843855261802673, 0.20716631412506104, 1.0], [0.0, 0.3380047082901001, 0.6239446997642517, 6.010197103023529e-05, 0.7040519118309021, 0.05022969841957092], [0.0, 0.33621808886528015, 0.526395320892334, 0.35611313581466675, 0.5769199132919312, 0.4400783181190491], [0.0, 0.33464792370796204, 0.7893296480178833, 0.1616135984659195, 0.8427752256393433, 0.2122565656900406], [0.0, 0.3313765525817871, 0.0, 0.21833011507987976, 0.23080405592918396, 0.7796567678451538], [0.0, 0.3295021951198578, 0.6871658563613892, 0.16251946985721588, 0.7505543231964111, 0.20261342823505402], [0.0, 0.32939413189888, 0.8877862691879272, 0.0, 1.0, 0.21754144132137299], [0.0, 0.3280572295188904, 0.683427095413208, 0.05675225332379341, 0.7324377298355103, 0.1061081737279892], [0.0, 0.3280175030231476, 0.7337505221366882, 0.21456307172775269, 0.7870777249336243, 0.26403456926345825], [0.0, 0.32741934061050415, 0.7871232628822327, 0.0, 1.0, 0.11095887422561646], [0.0, 0.32711800932884216, 0.6125258207321167, 0.7707194089889526, 1.0, 1.0], [0.0, 0.3256891369819641, 0.0, 0.9203382730484009, 0.0562296137213707, 1.0], [0.0, 0.32530954480171204, 0.35250425338745117, 0.0, 0.5488604307174683, 0.1449427455663681], [0.0, 0.324715256690979, 0.45405250787734985, 0.0, 0.6479468941688538, 0.14573422074317932], [0.0, 0.3244691491127014, 0.5747636556625366, 0.6804345846176147, 0.6344759464263916, 0.7449156045913696], [0.0, 0.3242606818675995, 0.0, 0.7802523374557495, 0.060774143785238266, 0.8526475429534912], [0.0, 0.3231322765350342, 0.4211777150630951, 0.7901055216789246, 0.4736692011356354, 0.8448881506919861], [0.0, 0.3225260376930237, 0.6855562329292297, 0.2695790231227875, 0.7485852837562561, 0.3097873032093048], [0.0, 0.3223261833190918, 0.5165964961051941, 0.30369797348976135, 0.5838491320610046, 0.37661054730415344], [0.0, 0.3190132975578308, 0.6840611696243286, 0.11031299084424973, 0.7345172166824341, 0.15836459398269653], [0.0, 0.31880688667297363, 0.5868977308273315, 0.7858849167823792, 0.6264750957489014, 0.8554143309593201], [0.0, 0.318799763917923, 0.10135529190301895, 0.6273577213287354, 0.16216304898262024, 0.6878644227981567], [0.0, 0.3178630471229553, 0.2491334080696106, 0.0, 0.4503113031387329, 0.1459662914276123], [0.0, 0.31764253973960876, 0.0, 0.729369044303894, 0.06217200309038162, 0.8002824783325195], [0.0, 0.316314160823822, 0.13572518527507782, 0.4907791018486023, 0.4709596633911133, 0.918556272983551], [0.0, 0.31614798307418823, 0.7361401319503784, 0.161359503865242, 0.7889970541000366, 0.21088607609272003], [0.0, 0.3158923387527466, 0.36976388096809387, 0.7920727729797363, 0.42588844895362854, 0.8462352752685547], [0.0, 0.3157651722431183, 0.36776894330978394, 0.8443600535392761, 0.4184507131576538, 0.8987955451011658], [0.0, 0.3152107894420624, 0.9517414569854736, 0.5720713138580322, 0.9960393905639648, 0.6536024808883667], [0.0, 0.31452468037605286, 0.6303567886352539, 0.056085046380758286, 0.6810942888259888, 0.10801681876182556], [0.0, 0.31429141759872437, 0.3200715184211731, 0.09504622220993042, 0.3662959933280945, 0.1773381233215332], [0.0, 0.314095675945282, 0.5308109521865845, 0.6801299452781677, 0.5753098726272583, 0.7513325810432434], [0.0, 0.3140608072280884, 0.6809313297271729, 0.2178284078836441, 0.7347820997238159, 0.26759111881256104], [0.0, 0.31373119354248047, 0.5221344232559204, 0.7350226640701294, 0.5814639329910278, 0.7973107099533081], [0.0, 0.3117356598377228, 0.4218320846557617, 0.20239503681659698, 0.4763789772987366, 0.28319358825683594], [0.0, 0.31127995252609253, 0.42516055703163147, 0.3630872070789337, 0.47294357419013977, 0.429222971200943], [0.0, 0.31101304292678833, 0.8473232388496399, 0.8993422389030457, 0.8852854371070862, 0.9573569893836975], [0.0, 0.30946406722068787, 0.5220901370048523, 0.7896288633346558, 0.575954258441925, 0.8456448316574097], [0.0, 0.3092215061187744, 0.5670506954193115, 0.9440076947212219, 0.639283299446106, 1.0], [0.0, 0.30905911326408386, 0.9063401818275452, 0.9130138158798218, 1.0, 1.0], [0.0, 0.3090510964393616, 0.5135889053344727, 0.5722286701202393, 0.578898549079895, 0.6422014236450195], [0.0, 0.30885469913482666, 0.5250933170318604, 0.8471934795379639, 0.5761620998382568, 0.9015847444534302], [0.0, 0.30866655707359314, 0.951046884059906, 0.35804468393325806, 0.997364342212677, 0.4444500803947449], [0.0, 0.3081985414028168, 0.16665951907634735, 0.052841365337371826, 0.44393396377563477, 0.5633533000946045], [0.0, 0.30809155106544495, 0.8756505250930786, 0.8173004388809204, 1.0, 1.0], [0.0, 0.30627647042274475, 0.4542831778526306, 0.4180346727371216, 0.6407758593559265, 0.6615869998931885], [0.0, 0.30577099323272705, 0.36145180463790894, 0.21161268651485443, 0.43976718187332153, 0.26231950521469116], [0.0, 0.3056153357028961, 0.950568675994873, 0.6223926544189453, 0.9963271617889404, 0.7067312002182007], [0.0, 0.3048050105571747, 0.7901118397712708, 0.3691854476928711, 0.8498157858848572, 0.4268338680267334], [0.0, 0.3046548366546631, 0.4767646789550781, 0.6647834181785583, 0.9210307598114014, 1.0], [0.0, 0.3040694296360016, 0.9493268132209778, 0.7254079580307007, 0.9974527955055237, 0.8113071918487549], [0.0, 0.3036992847919464, 0.7842162847518921, 0.522617757320404, 0.8383376598358154, 0.5814014077186584], [0.0, 0.3035878539085388, 0.0, 0.5602916479110718, 0.15254323184490204, 0.7438892126083374], [0.0, 0.3035617172718048, 0.9525880217552185, 0.41422122716903687, 0.9983840584754944, 0.49657273292541504], [0.0, 0.3034290373325348, 0.09489327669143677, 0.9379873275756836, 0.168815016746521, 1.0], [0.0, 0.30334362387657166, 0.3615919351577759, 0.9473257064819336, 0.42423540353775024, 1.0], [0.0, 0.302979052066803, 0.4229004383087158, 0.1517314910888672, 0.4750792980194092, 0.2332150936126709], [0.0, 0.30288878083229065, 0.5509763360023499, 0.16333407163619995, 0.7436758875846863, 0.3406045436859131], [0.0, 0.302875816822052, 0.5253306031227112, 0.41257160902023315, 0.5755682587623596, 0.4916040897369385], [0.0, 0.3023538291454315, 0.7781322598457336, 0.9446988105773926, 0.8505274653434753, 1.0], [0.0, 0.3018416464328766, 0.04201468452811241, 0.0, 0.12768010795116425, 0.05132518336176872], [0.0, 0.3018025755882263, 0.638735294342041, 0.11266299337148666, 0.700247049331665, 0.15081219375133514], [0.0, 0.3017869293689728, 0.8701384663581848, 0.22678041458129883, 1.0, 0.47191929817199707], [0.0, 0.30173516273498535, 0.46991971135139465, 0.5788829326629639, 0.5528373718261719, 0.6279313564300537], [0.0, 0.3015425503253937, 0.702499508857727, 0.4966621398925781, 1.0, 0.8961905241012573], [0.0, 0.30097973346710205, 0.0, 0.6766150593757629, 0.062443431466817856, 0.7492969632148743], [0.0, 0.2999502122402191, 0.46926426887512207, 0.7879582643508911, 0.5222427248954773, 0.8441793918609619], [0.0, 0.2998069226741791, 0.8383838534355164, 0.7387928366661072, 0.9041901230812073, 0.7820411324501038], [0.0, 0.2997302711009979, 0.6266809701919556, 0.6829532384872437, 0.687191367149353, 0.7437620162963867], [0.0, 0.29922932386398315, 0.2766895890235901, 0.7345049381256104, 0.7165694832801819, 1.0], [0.0, 0.29915371537208557, 0.6280661225318909, 0.37325695157051086, 0.701719343662262, 0.41669437289237976], [0.0, 0.2988787591457367, 0.9512851238250732, 0.521103024482727, 0.9948536157608032, 0.6019420623779297], [0.0, 0.2982707619667053, 0.0020293742418289185, 0.5068413615226746, 0.05407947301864624, 0.5978963971138], [0.0, 0.2981034517288208, 0.8889434337615967, 0.6884158253669739, 0.9598939418792725, 0.731789767742157], [0.0, 0.29724669456481934, 0.7976745367050171, 0.5782050490379333, 0.8368011713027954, 0.6447365880012512], [0.0, 0.29685869812965393, 0.9411171078681946, 0.785904049873352, 1.0, 0.8544464111328125], [0.0, 0.29628944396972656, 0.25656986236572266, 0.0014236383140087128, 0.3422602415084839, 0.05571365728974342], [0.0, 0.29552161693573, 0.11159392446279526, 0.10173332691192627, 0.1531572937965393, 0.17168718576431274], [0.0, 0.2954811751842499, 0.0, 0.21423587203025818, 0.0765061229467392, 0.2614700198173523], [0.0, 0.2952989935874939, 0.15916989743709564, 0.32192519307136536, 0.3372461199760437, 0.5637787580490112], [0.0, 0.2952832579612732, 0.5180695056915283, 0.6282444000244141, 0.5831331014633179, 0.6977766752243042], [0.0, 0.2950413227081299, 0.8828567266464233, 0.939605712890625, 0.9554505348205566, 1.0], [0.0, 0.2945857346057892, 0.32042452692985535, 0.37924274802207947, 0.3600386679172516, 0.43792232871055603], [0.0, 0.2944544851779938, 0.373241662979126, 0.37452229857444763, 0.41563618183135986, 0.4352876842021942], [0.0, 0.2942132353782654, 0.8290576934814453, 0.9420439600944519, 0.902672529220581, 1.0], [0.0, 0.2941124439239502, 0.5380184054374695, 0.37435197830200195, 0.6709570288658142, 0.5188630819320679], [0.0, 0.2940295338630676, 0.7430799603462219, 0.11170899868011475, 0.8037078976631165, 0.15102824568748474], [0.0, 0.293331116437912, 0.35394763946533203, 0.34981769323349, 0.5498237609863281, 0.5380789637565613], [0.0, 0.29332756996154785, 0.4114592671394348, 0.9471758604049683, 0.4766947627067566, 1.0], [0.0, 0.29272541403770447, 0.5713214874267578, 0.0004309359937906265, 0.6492958068847656, 0.05033056437969208], [0.0, 0.2925208806991577, 0.7396335005760193, 0.05556988716125488, 0.7874881625175476, 0.10414917767047882], [0.0, 0.29249969124794006, 0.47896528244018555, 0.7397496700286865, 0.5195545554161072, 0.8028196096420288], [0.0, 0.2924167215824127, 0.933567464351654, 0.0, 1.0, 0.05580366402864456], [0.0, 0.29215577244758606, 0.4724491238594055, 0.84593665599823, 0.5229489803314209, 0.8991013765335083], [0.0, 0.2921390235424042, 0.4273237884044647, 0.6821130514144897, 0.47838541865348816, 0.7363201379776001], [0.0, 0.2918897867202759, 0.9429163932800293, 0.8406599760055542, 1.0, 0.9075591564178467], [0.0, 0.2918473780155182, 0.5128514170646667, 0.9449970126152039, 0.5849166512489319, 1.0], [0.0, 0.2911980152130127, 0.3602719008922577, 0.0, 0.4299685060977936, 0.06602838635444641], [0.0, 0.29032817482948303, 0.4254702925682068, 0.3083078861236572, 0.47212082147598267, 0.3808460235595703], [0.0, 0.2898170053958893, 0.7874332666397095, 0.2158052623271942, 0.8402680158615112, 0.26326441764831543], [0.0, 0.28945106267929077, 0.0, 0.0, 0.20739901065826416, 0.11667156964540482], [0.0, 0.2893337309360504, 0.4705773890018463, 0.4750300943851471, 0.5540667772293091, 0.5243601202964783], [0.0, 0.289265900850296, 0.6800929307937622, 0.0, 0.7377841472625732, 0.06092862784862518], [0.0, 0.2889595627784729, 0.8434596657752991, 0.31377309560775757, 0.8996695876121521, 0.370649516582489], [0.0, 0.2888559401035309, 0.37120816111564636, 0.04520254209637642, 0.4176694452762604, 0.1255854219198227], [0.0, 0.28823786973953247, 0.4785866141319275, 0.9381502866744995, 0.5244562029838562, 1.0], [0.0, 0.2881348431110382, 0.20553499460220337, 0.8335792422294617, 0.26337143778800964, 0.8998133540153503], [0.0, 0.28776055574417114, 0.848702073097229, 0.7896995544433594, 0.8853460550308228, 0.8488997220993042], [0.0, 0.28757259249687195, 0.8688817024230957, 0.12569433450698853, 1.0, 0.37085333466529846], [0.0, 0.2872491776943207, 0.5691465735435486, 0.25578054785728455, 0.6365798115730286, 0.32962414622306824], [0.0, 0.28710606694221497, 0.20785976946353912, 0.3741651475429535, 0.2643526792526245, 0.42936912178993225], [0.0, 0.287015825510025, 0.6081342697143555, 0.3686332702636719, 1.0, 0.6216212511062622], [0.0, 0.28659290075302124, 0.3108674883842468, 0.2117319256067276, 0.3869855999946594, 0.2622150182723999], [0.0, 0.28577154874801636, 0.3714808523654938, 0.09464675933122635, 0.41979309916496277, 0.17836514115333557], [0.0, 0.28570878505706787, 0.8963097929954529, 0.05641122907400131, 0.9497058987617493, 0.11036554723978043], [0.0, 0.28569257259368896, 0.9403613209724426, 0.2626246213912964, 1.0, 0.3157275915145874], [0.0, 0.2856108546257019, 0.5140482783317566, 0.26451432704925537, 0.5973600745201111, 0.3160684108734131], [0.0, 0.2852841019630432, 0.6335992217063904, 0.0, 0.679035484790802, 0.07775532454252243], [0.0, 0.28523746132850647, 0.57380610704422, 0.7360888123512268, 0.6322826743125916, 0.7948341965675354], [0.0, 0.2850608825683594, 0.2614211142063141, 0.4769710600376129, 0.3177346885204315, 0.5308374166488647], [0.0, 0.2847842574119568, 0.7914046049118042, 0.05570163577795029, 0.8404449224472046, 0.10548176616430283], [0.0, 0.2846382260322571, 0.25523650646209717, 0.9453313946723938, 0.318317174911499, 1.0], [0.0, 0.2845005393028259, 0.8596287369728088, 0.35657915472984314, 1.0, 0.5540792346000671], [0.0, 0.2843627333641052, 0.41853857040405273, 0.5140296220779419, 0.4780052900314331, 0.5822768211364746], [0.0, 0.28411853313446045, 0.7431882619857788, 0.5747441649436951, 0.7822370529174805, 0.6451032757759094], [0.0, 0.2838780879974365, 0.48433569073677063, 0.7505739331245422, 0.6222746968269348, 0.8824090361595154], [0.0, 0.28370994329452515, 0.5477281808853149, 0.4361770451068878, 0.740065336227417, 0.6665181517601013], [0.0, 0.28352266550064087, 0.0, 0.6035395860671997, 0.19002968072891235, 0.9050962924957275], [0.0, 0.28339964151382446, 0.5550472736358643, 0.06040928512811661, 0.7510890960693359, 0.2383417785167694], [0.0, 0.28322362899780273, 0.8587049245834351, 0.4579421281814575, 1.0, 0.655707836151123], [0.0, 0.2831907868385315, 0.6806806325912476, 0.3685862123966217, 0.7362295389175415, 0.4201270043849945], [0.0, 0.28298673033714294, 0.4577640891075134, 0.9509414434432983, 0.5475930571556091, 0.9990087747573853], [0.0, 0.2825695276260376, 0.6534325480461121, 0.0, 0.8546033501625061, 0.1414952278137207], [0.0, 0.2825687825679779, 0.32393306493759155, 0.0, 0.46664130687713623, 0.0958959311246872], [0.0, 0.28248947858810425, 0.7344797849655151, 0.0, 0.792578935623169, 0.059951916337013245], [0.0, 0.2822904884815216, 0.25265052914619446, 0.25429606437683105, 0.4493076503276825, 0.44751179218292236], [0.0, 0.2821846306324005, 0.3152012228965759, 0.7858959436416626, 0.37233418226242065, 0.8456672430038452]]}まとめ

トレーニングビデオを参考に、ミツバチの物体検出モデルを作成しました。画像をアノテーションしてファイルをアップロードし、GUI上でちょちょいと設定を書いて学習するだけで、物体検出ができます。今後は、ハイパーパラメータの設定やチューニング方法、再学習して運用する方法などについて学んでいきましょう。

- 投稿日:2019-12-09T23:19:07+09:00

家の環境(温度・湿度・大気圧)をAWSに蓄積して分析してみるの巻 その2

前回まで

今回の内容

今回は、AWS IoT向けにデバイスからpublishするところまで作業します。

先にデバイス側のコードを紹介

aws-iot-publish.ino#include <time.h> #include <ESP8266WiFi.h> #include <WiFiClientSecure.h> #include <PubSubClient.h> #include "BME280SPI.h" #define JST 3600*9 const String wifiSSID = "<yourSSID>"; // お使いのWiFiのSSIDを入力してください const String wifiPass = "<yourPass>"; // お使いのWiFiのパスワードを入力してください const uint8_t pinLED = 14; // 緑LEDピン番号 const uint8_t pinSW = 0; // タクトスイッチSW1ピン番号 const uint8_t pinBME280CS = 15; // BME280センサーCSピン番号 const uint8_t pinSDCS = 2; // SDカードCSピン番号 const char* server = "<AWS IoTのエンドポイント>"; const int port = 8883; const char* pubTopic = "<トピック名>"; const char* Root_CA = \ "-----BEGIN CERTIFICATE----\n" \ "~\n" \ "~\n" \ "中略\n" \ "-----END CERTIFICATE-----\n"; const char* Client_cert = \ "-----BEGIN CERTIFICATE-----\n" \ "~\n" \ "~\n" \ "中略\n" \ "-----END CERTIFICATE-----\n"; const char* Client_private = \ "-----BEGIN RSA PRIVATE KEY-----\n" \ "~\n" \ "~\n" \ "中略\n" \ "-----END RSA PRIVATE KEY-----\n"; WiFiClientSecure espClient; PubSubClient mqttClient(espClient); //--------------------------------- // 変数 BME280SPI bme280(pinBME280CS); // BME280センサーを制御するクラス bool statWiFiConnected = true; // WiFiに接続されているかを記憶しておく uint32_t lastStat = 0; // 最後にstat()を実行した時間を記憶しておく char currentTimeStr[19]; //--------------------------------- // 関数 void connectAWSIoT() { while (!mqttClient.connected()) { if (mqttClient.connect("ESP8266")) { Serial.println("AWSIoT Connected."); } else { Serial.print("Failed. Error state="); Serial.print(mqttClient.state()); // Wait 5 seconds before retrying delay(5000); } } } void mqttCallback (char* topic, byte* payload, unsigned int length) { Serial.print("Received. topic="); Serial.println(topic); for (int i = 0; i < length; i++) { Serial.print((char)payload[i]); } Serial.print("\n"); } void mqttLoop() { if (!mqttClient.connected()) { connectAWSIoT(); } mqttClient.loop(); } void getCurrentDateTimeStr() { time_t t; struct tm *tm; t = time(NULL); tm = localtime(&t); sprintf(currentTimeStr,"%04d/%02d/%02d %02d:%02d:%02d", tm->tm_year+1900, tm->tm_mon+1, tm->tm_mday, tm->tm_hour, tm->tm_min, tm->tm_sec); } void setup() { Serial.begin(115200); delay(1); Serial.printf("\n\n-----------------------\n"); Serial.printf("Program Start\n"); pinMode(pinLED, OUTPUT); // LED pinMode(pinSW, INPUT); // SW1 // SPI CSピンをHighにする pinMode(pinBME280CS, OUTPUT); pinMode(pinSDCS, OUTPUT); digitalWrite(pinBME280CS, HIGH); digitalWrite(pinSDCS, HIGH); // BME280 Measure until success while(BME280SPI::statSuccess!=bme280.meas()){ Serial.print("BME280 is not available\n"); delay(5000); } // WiFi Serial.printf("\nWiFi"); WiFi.mode(WIFI_STA); WiFi.begin(wifiSSID.c_str(), wifiPass.c_str()); // 接続完了まで待つ while(WiFi.status()!=WL_CONNECTED){ delay(1000); } Serial.printf(" Connected IP : "); Serial.println(WiFi.localIP()); //時刻合わせ configTime( JST, 0, "ntp.nict.jp", "ntp.jst.mfeed.ad.jp"); delay(5000); getCurrentDateTimeStr(); Serial.printf("Current date-time is "); Serial.println(currentTimeStr); //AWSへの接続処理 //証明書、秘密鍵のオブジェクト作成 BearSSL::X509List cert(Root_CA); BearSSL::X509List client_crt(Client_cert); BearSSL::PrivateKey key(Client_private); //証明書、秘密鍵の設定 espClient.setTrustAnchors(&cert); espClient.setClientRSACert(&client_crt, &key); //接続処理 mqttClient.setServer(server, port); mqttClient.setCallback(mqttCallback); connectAWSIoT(); } // 5秒おきに動作状況を確認する処理 void stat(){ pinMode(pinLED, OUTPUT); if(WiFi.status()==WL_CONNECTED){ // WiFi切断 -> 接続に変わった場合ログを残す if(!statWiFiConnected){ statWiFiConnected = true; Serial.println(" WiFi Connected"); Serial.println(WiFi.localIP()); } // 正常状態 LEDを1回点滅 digitalWrite(pinLED, 1); delay(100); digitalWrite(pinLED, 0); }else{ // WiFi接続 -> 切断に変わった場合ログを残す if(statWiFiConnected){ statWiFiConnected = false; Serial.printf(" WiFi Disconnected\n"); } // WiFi切断状態 LEDを2回点滅 digitalWrite(pinLED, 1); delay(50); digitalWrite(pinLED, 0); delay(450); digitalWrite(pinLED, 1); delay(50); digitalWrite(pinLED, 0); } } // センサーの気温、気圧、湿度をAWSにpublishする void publishToAWS() { Serial.printf("Start publishing data to AWS\n"); // 測定処理おこなう bme280.meas(); // センサーからデータ取得に失敗 if(!bme280.getResult()){ Serial.printf(" BME280 Not Available\n"); return; } getCurrentDateTimeStr(); String json = "{"; json += "\"time\":\""; json += currentTimeStr, json += "\","; json += "\"temperature\":\""; json += bme280.getMeasStr(BME280SPI::selectTemp).c_str(); json += "\","; json += "\"humidity\":\""; json += bme280.getMeasStr(BME280SPI::selectHumidity).c_str(); json += "\","; json += "\"temperature\":\""; json += bme280.getMeasStr(BME280SPI::selectPressure).c_str(); json += "\"}"; Serial.println(json); if(!mqttClient.publish(pubTopic, json.c_str())){ Serial.println("Failed to publish\n"); }else{ Serial.println("Succeed to publish\n"); } } void loop() { if(millis() > lastStat+5000){ // 5秒おきに実行 lastStat = millis(); stat(); publishToAWS(); } delay(1); // 消費電力低減 mqttClient.loop(); }ポイント

全体的に

- ループとかwifi接続とかの実装はこちらの公式サンプルを参考に実装。

- とりあえずpublishすることを優先したので、実装的に変なとこありますがご容赦ください。

証明書・秘密鍵について

- とりあえず今回はベタ書きしました。

- 最初、ここのやり方を参考に実装したけどうまくいかず。

- こんなエラーが出た

error: no matching function for call to BearSSL::WiFiClientSecure::setCACert(const char*&)- 参考にしてた人のライブラリがESP32用で、

WifiSecureClientの実装が同名ながら違っていた(今回使ったのはESP8266)- 最終的にここを見て解決

- この参考記事には時刻合わせも必要という記載があったのでここを参考に実装しました。

センサー情報の取得について

- 公式のサンプルを元に実装しました。

掲載コード以外でやったこと

- 最初のほう、

fork/exec /Users/yourusername/Library/Arduino15/packages/esp8266/tools/python3/3.7.2-post1/python3: no such file or directoryというエラーが出ました。

- この記事を参考に対処して解決。

PubSubClient.hのパラメーターをいじりました。

MQTT_MAX_PACKET_SIZEを256に。

- publishに失敗する原因を切り分けてるうちに、publishするデータ長によって成否が分かれたので気づいた。

MQTT_KEEPALIVEを30に。

- ここに書いてたのでとりあえず。

- とりあえず動作確認する際は、AWS IoTのテスト機能でpublishしたデータをsubscribeできるか確認しました。デバイスがpublishするトピックをテスト機能のほうでsubscribeして、うまくいけばpublishされたデータが見れるようになります。

次回やる予定

publishしたデータをDynamoDBにぶち込んで何しか可視化したいと思います。

他、参考記事

https://blog.maripo.org/2017/07/esp32-aws-iot/

https://blog.maripo.org/2017/07/esp32-aws-iot-troubleshooting/

- 投稿日:2019-12-09T22:58:27+09:00

AWSの多要素認証に1passwordが使えたけど使っちゃダメだと思った話

1passwordのアイテム編集画面で、フィールドタイプを眺めててふと思った。「ワンタイムパスワードってあるけど、これ、AWSで多要素認証するときの『仮想MFAデバイス』に使えるのでは」と。結論から言えば、使えた。快適。でもこれは多分「人をダメにするナントカ」的な快適さだ。やっちゃいけないやつだ。

AWSの多要素認証

AWSでは、AWSアカウントの管理者であるrootユーザー(メールアドレスでログインする人)と、利用者であるIAMユーザー(ユーザーIDでログインする人)のどちらでも、多要素認証(MFA:Multi-Factor Authentication)を設定して認証を強化できる。

- 認証方法はパスワード認証+ワンタイムパスワード(当人が知っていること+当人が持っているもの)

- ワンタイムパスワードの生成には、専用のデバイスであるU2FセキュリティキーやハードウェアMFAデバイス、スマホアプリである仮想MFAデバイスのどちらかが使える

- SMSによる認証もプレビュー提供されていたものの「間もなく(略)サポートを終了します。新規のお客様が、この機能をプレビューすることはできません」。

利用できるスマホアプリは「IAM - Multi-factor Authentication」の「Virtual MFA Applications」にまとめられていて、現時点ではAuthy、Duo Mobile、LastPass Authenticator、Microsoft Authenticator、Google Authenticatorがリストアップされていた。

僕は当初、自分のiPhoneにGoogle Authenticatorをインストールし、IAM ユーザーの仮想 MFA デバイスの有効化を行って、2段階認証でAWSにログインできることを確認した。

1passwordによるMFA

1passwordに記録していたIAMユーザー情報を修正していて、ふとフィールドタイプに「ワンタイムパスワード」があるのが気になった。AWS側では、仮想MFAデバイスの要件として次のように書いている。

電話や他のデバイスを仮想多要素認証 (MFA) デバイスとして使用できます。これを行うには、標準ベースの TOTP (時刻ベースのワンタイムパスワード) アルゴリズムである RFC 6238 に準拠するモバイルアプリをインストールします。これらのアプリは、6 桁の認証コードを生成します。

(仮想 Multi-Factor Authentication (MFA) デバイスの有効化 (コンソール) - AWS Identity and Access Management)1passwordのワンタイムパスワード機能は、リリース時のブログエントリーを見るとTOTPであるらしい。

1Password 5.2 for iOS and 1Password 4.1.0.538 for Windows are out, and they provide support for using Time-based One Time Passwords (TOTP) in your Logins

(TOTP for 1Password users | 1Password)これ、もしかして1passwordも使えるのでは、と思って試してみた。1password登録されたIAMユーザー情報にワンタイムパスワードフィールドを追加するとして、手順は「仮想 Multi-Factor Authentication (MFA) デバイスの有効化 (コンソール)」を1password用に編集すると、こうなる。

- AWS マネジメントコンソール にサインインし、IAM コンソールを開きます。

- ナビゲーションペインで [ユーザー] を選択します。

- [ユーザー名] リストから対象の MFA ユーザーの名前を選択します。

- [Security credentials] タブを選択します。[Assigned MFA device (割り当て済み MFA デバイス)] の横で、[管理] を選択します。

- [MFA デバイスの管理] ウィザードで、[仮想 MFA デバイス]、[Continue (続行)] の順に選択します。

- 1passwordを開きます。IAMユーザー情報を登録したアイテムを開き、編集状態にします。ユーザーIDやパスワードのフィールドの下に、新しいフィールドを追加し、「ワンタイムパスワード」タイプを選びます。

- AWSの[MFA デバイスの管理] ウィザードで [手動設定のシークレットキーを表示] を選択し、1passwordに追加した「ワンタイムパスワード」フィールドに入力し、保存します。

- [MFA デバイスの管理] ウィザードの [MFA code 1 (MFA コード 1)] ボックスに、1passwordに表示されているワンタイムパスワード(6桁の数字)を入力します。デバイスが新しいワンタイムパススワードを生成するまで待ちます (最長 30 秒)。生成されたら [MFA code 2 (MFA コード 2)] ボックスに 2 つ目のワンタイムパススワードを入力します。[Assign MFA (MFA の割り当て)] を選択します。

これで1passwordでワンタイムパスワードを生成できるようになり、AWS側も多要素認証でログインできるようになった。実際にログインしてみると、通常時のIDとパスワードと同様に、ワンタイムパスワードも自動(または半自動)入力されるようになる。ログインがとても簡単、快適になる。

でもMFAで1password使っちゃダメかもと思う

Windows上の1passwordでワンタイムパスワードのフィールドを追加して、その後iPhone上の1passwordを見てみると、当然だけどデータは同期されワンタイムパスワードのフィールドが出てきた。iPhone上でAWSのコンソールにログインしたところ、こちらでも多要素認証でうまく認証された。すごく便利。でもこれはよくないことかもしれない。僕は「仮想 MFA デバイスの交換または更新」を参照して、1passwordを無効化し、Google Authenticatorを登録しなおした。

Windows(具体的には社有のSurface Pro)上の1passwordとiPhone上の1passwordの両方でMFAの二段階目をクリアできたということは、もうこの2段階目は特定のデバイスを持っていることに依存しないということだ。僕のIDで他のデバイスに1passwordをインストールすることができれば、さらにそのデバイスでも2段階目をクリアできる。「AWSのパスワード」と「特定のスマホ(デバイス)」ではなく、「AWSのパスワード」と「1passwordのマスターパスワード」でAWSにログインできてしまう。

MFA(多要素認証)で求められるのは「多段階」ということではない。知識、所有物、生体情報のうち2種類以上の要素を組合わせて使うことだ。「AWSのパスワード」と「1passwordのマスターパスワード」では、どちらも「知識」だから1種類の要素しか使っていない。これは多段階認証ではあっても多要素認証ではない。僕が複数のデバイスで使えるワンタイムパスワード生成アプリを選んでしまったから、そうなっちゃったのだ。求められているのがワンタイムパスワードだけなら1passwordを活用すべきだけど、MFAなら1passwordを組み合わせちゃいけなかった。

古い話だけど「タスポ(taspo)」の運用が開始された頃に自販機にタスポを添付した店主がいて、「財務省の福岡の出先や日本たばこ産業から『なるべくやめてほしい』と電話などで注意を受けたというが、店主は『法律違反ではないはず』と、撤去の意向はない」と報じられた。同じようにAWSの多要素認証化も、導入時には「設定しました」「これからはMFA必須です」だけでは、僕のように快適だけどMFAを台無しにする組み合わせを選択しちゃうかもしれない。なんでMFAを導入するのかとかMFAってなんのことなのかとか、認識と思いを共有しないとコケそうだ。

参照

- 投稿日:2019-12-09T22:02:54+09:00

クラウドはdhcpが当たり前

さて、つい最近とあるプロジェクトにて。

「Azureの設定的には、インタフェースには静的なIPを振りますが、OSの設定としてはdhcpを設定します」

と説明したところ

「そんなのあり得ない!」

という反応を受けました。

どうやら「クラウドに中途半端に詳しい人が勘違いしてることあるある」っぽいネタのようですので、解説していきたいと思います。Azure(やらAWSやら)では基本的にOS設定はDHCP

さて、皆さんはAzure、或いはAWSで新規に仮想マシンを建てる時、OSの中身はほぼデフォルト設定になっているという事は理解されているかと思います。

OSのデフォルト設定は、DHCP設定なのです。

つまり、事実として、OSはDHCP設定のままでいると、AzureなりAWSなりが設定している「ネットワークの設定」が設定される仕組みになっているのです。その際、サブネットマスクだの、デフォルトゲートウェイだの、DNSだのが自動で設定されるのです。DHCP設定しないとどうなるの?

こまる事だらけです。

特に[VMのクローンを作る]という時に大変困った事になります。

例えばOSの設定として、192.168.0.10というアドレスを設定してしまったとしましょう。すると、そのクローンとして192.168.0.11というIPアドレスを持つクローンを作っても、そのクローンはパケットを受信して来れません。そのクローンの仮想マシンは、自分のIPを192.168.0.10だと思っているからです。

バカハブという言葉を聞いた事がありますか?とにかくネットワークに流れるパケットを、つながっている全てのノードに送信してしまうハブの事です。最近はめったに見なくなりました。ネットワークのキャプチャなどで大変に役に立つものです。

そして、そのバカハブにつないでも、大抵のPCは混乱なく通信をする事が可能です。それは、自分のIPアドレスを知っていて、そのIP以外の通信を受け取らない、という仕組みが出来ているからです。クラウドの設定と、OSの設定は違うんだよ

「何を当たり前の事を言ってるんだ」と思われるかもですが、これが理解出来ていない人、ホントに多いんですよ。

上記を読めば、まさかの勘違いも解消するかもと思っているのですが、ウチの職場で延々と「わからない」を繰り返している方がいらっしゃったので、改めて執筆してみました。

- 投稿日:2019-12-09T22:02:54+09:00

クラウドはhdcpが当たり前

さて、つい最近とあるプロジェクトにて。

「Azureの設定的には、インタフェースには静的なIPを振りますが、OSの設定としてはdhcpを設定します」

と説明したところ

「そんなのあり得ない!」

という反応を受けました。

どうやら「クラウドに中途半端に詳しい人が勘違いしてることあるある」っぽいネタのようですので、解説していきたいと思います。Azure(やらAWSやら)では基本的にOS設定はDHCP

さて、皆さんはAzure、或いはAWSで新規に仮想マシンを建てる時、OSの中身はほぼデフォルト設定になっているという事は理解されているかと思います。

OSのデフォルト設定は、DHCP設定なのです。

つまり、事実として、OSはDHCP設定のままでいると、AzureなりAWSなりが設定している「ネットワークの設定」が設定される仕組みになっているのです。その際、サブネットマスクだの、デフォルトゲートウェイだの、DNSだのが自動で設定されるのです。DHCP設定しないとどうなるの?

こまる事だらけです。

特に[VMのクローンを作る]という時に大変困った事になります。

例えばOSの設定として、192.168.0.10というアドレスを設定してしまったとしましょう。すると、そのクローンとして192.168.0.11というIPアドレスを持つクローンを作っても、そのクローンはパケットを受信して来れません。そのクローンの仮想マシンは、自分のIPを192.168.0.10だと思っているからです。

バカハブという言葉を聞いた事がありますか?とにかくネットワークに流れるパケットを、つながっている全てのノードに送信してしまうハブの事です。最近はめったに見なくなりました。ネットワークのキャプチャなどで大変に役に立つものです。

そして、そのバカハブにつないでも、大抵のPCは混乱なく通信をする事が可能です。それは、自分のIPアドレスを知っていて、そのIP以外の通信を受け取らない、という仕組みが出来ているからです。クラウドの設定と、OSの設定は違うんだよ

「何を当たり前の事を言ってるんだ」と思われるかもですが、これが理解出来ていない人、ホントに多いんですよ。

上記を読めば、まさかの勘違いも解消するかもと思っているのですが、ウチの職場で延々と「わからない」を繰り返している方がいらっしゃったので、改めて執筆してみました。

- 投稿日:2019-12-09T20:45:54+09:00

AWS re:Inventを有意義に過ごすための10個のTips

これはMedia Doアドベントカレンダーの何日目かわからない記事です。

先日、ラスベガスで開催されたAWS re:Invent2019に参加してきました。

そのときに「次行くときはこうしよう」と思ったことをTipsとしてまとめます。①セッション予約は登録解禁後すぐやろう

re:Inventのセッション予約は、開催約2ヶ月前の日本時間深夜2時に開始されます。

そのとき、「明日の昼ぐらいに予約すればいいや」とか思っていると人気のセッションはすぐ埋まってしまっていました。re:Invent全体の参加者約7万人に対して、セッションの会場は数百人程度なのですごい競争率です。なのでセッションの予約は開始直後にやってしまいましょう。

予約開始時にすぐ目当てのセッションを予約するには、当然それより前に公開されているセッション一覧に目を通しておく必要があります。re:Inventでのセッションの総数はおよそ3000個もあって、この一覧に目を通すことすら難しいので、サーバーレスとか機械学習、ブロックチェーンなど、自分が興味のあるトピックをあらかじめ絞っておくと良いと思います。(というか、そうしないと厳しいです)

②通常SessionよりWorkshop、Chalk Talkなどを優先しよう

re:Inventのセッションには色々種類があります。主なものは以下のとおりです。

- Keynote: 基調講演

- Session: スピーカーが喋っているのを約1時間聞くだけ

- Chalk Talk: 15分講演、残り45分は質疑応答という少人数セッション

- Workshop: 2時間程度の時間で実際手を動かして何かを作ったりするハンズオン形式

- Builder Session: Workshopをさらに少人数(6人とか)で行う

re:InventのセッションにはYoutubeで動画公開されるものとされないものがあります。KeynoteやSessionに関しては動画公開され、内容としても基本的にはスピーカーが喋っているのを聞くだけです。主要なKeynoteについては演出も凝っていて会場の興奮度も高いのでぜひ生で参加して会場の雰囲気含めて楽しみたいところですが、それ以外の通常SessionよりはなるべくWorkshopやChalk Talkを優先して受講すると良いと思います。

③セッションのキャンセル待ちは難しいのでなるべく避けよう

予約できなかったセッションにどうしても参加したい場合、キャンセル待ちすることになります。

re:Invent開催前までは、キャンセル待ちリストに登録されて運が良ければ繰り上がるという形ですが、re:Invent開催期間中のキャンセル待ちは、実際にセッション開始前に行列に並び、正規の登録者が遅刻などして欠員が出た場合にのみセッション参加が認められる運用になります。

その場合、原則としてセッション開始1時間前から待ち行列が作られます。しかしDeepComposerのハンズオンなどはあまりの人気ぶりから、スタッフが早めに待ち行列の案内を始め、規定通りのセッション開始1時間前に行ったらすでにキャンセル待ち50人とかになっておりキャンセル待ちが絶望的な状況が発生していました。なので行列が作られると想定される場所の近くに待機して、行列が始まったらすぐ並ぶようにしましょう。とういうかそもそも、セッションの予約を計画的に行い、キャンセル待ちに並ばずに受講できるようにしましょう。。

ちなみに各セッションは開始10分前までに入場手続きをしないと問答無用で予約が取り消され、キャンセル待ちの人を優先して入場させていました。(おそらくセッション開始時間を厳守するため)

④なるべくVenetianの近くに泊まろう

Venetianというホテルがre:Inventのメイン会場となっており、Keynote(基調講演)などの主要なプログラムはそこで行われます。なので、移動を楽にするためにできるだけVenetian、またはVenetianの近くのホテルに泊まるのがおすすめです。

セッション間の時間はけっこうみんな廊下の地べたに座って休憩していましたが、できればゆっくり休みたいので部屋に戻りやすい環境を作りたいところです。Certificate LoungeというAWS認定資格を持った人だけ入れる休憩所も用意されていますが、今年はその休憩所がVenetianにしかない、かつそんなに広くなく(50席ぐらい)常に満員だったので、セッション間の空き時間をCertificate Loungeで潰すという方針はそんなにおすすめできないかな、という印象でした。

ちなみに今回、Certificate Loungeを使うために渡米前にソリューションアーキテクトアソシエイトを取得したのですが、そんなわけで別に取らなくても良かったです。(ただ、それをモチベーションにして計画的に勉強できたのは良かったです)

⑤新サービス発表後、セッション受講スケジュールを再確認しよう

re:InventではおもにKeynoteで新サービスの発表がおこなわれます。そしてそれと同時にその新サービスに関連するハンズオンなどが開講されます。

なので発表されたばかりの新サービスをいち早くキャッチアップしたい!となったら新サービス発表後にその関連セッションを探して予約しましょう。

このとき、「NEW LAUNCH」というキーワードでスケジュール検索すると、新サービスのセッションをかんたんに絞り込みできるのでおすすめです。

ちなみに、その年の新サービスが発表される主なタイミングは以下の2つです。

- 0日目のMidnight Madness(前夜祭)の最後

- 例年、DeepLens, DeepRacer, DeepComposerなど機械学習がらみのガジェットが発表され、そのハンズオンに参加すると現物をもらうことができます。かなり競争率高いです

- 2日目の朝のKeynote

- AWS CEOによるre:Inventで一番重要なKeynoteです。ここでかなりの数の新サービスが発表されます

⑥ラスベガスのホテル施設には期待しないでおこう

僕が泊まったのは某4つ星ホテルでしたが、

- ウォシュレットなし

- ガウンなし

- スリッパなし

- 冷蔵庫なし(備え付けの冷蔵庫の中身を動かすと使用したとみなされて使用料50ドル+飲み物代がかかり、実質使えない)

と、値段の割には...という内容でした。他のホテルも設備的にはだいたい同じようなものでした。

なので、ラスベガスの高級ホテルといっても設備には期待しないほうがいいかもしれません。⑦レンタルWi-Fi、プリペイドSIMはなくても何とかなるぞ

今回、レンタルWi-Fiを持っていきましたが、基本的にre:Inventの会場となる各ホテルにはそのホテルの無料Wi-FiとAWSの無料Wi-Fiが飛んでいるので、会場間の移動時ぐらいにしか持っていったWi-Fiを使うことはありませんでした。その会場間の移動時もシャトルバスが出ているのでUberを使う機会もありませんでした。

⑧無料の食べ物・飲み物で食いつなごう

re:Inventの会場では、昼食やおやつが支給されます。

昼食はビュッフェとGrab&Go(要は弁当)の2種類があって、会場で食べるか持ち帰って部屋などで食べるかを選択できますが、弁当は個人的にかなり量が多かったので、次の日の朝ごはんにしたりなどしていました。

水やコーヒーはホテルの色んな所に設置されていて、だいたいいつでも飲むことができますし、昼食やおやつの時間にはコーラやスプライト、紅茶などのソフトドリンクも支給されます。

なのでre:Invent開催中の食事代は夕食分ぐらいしかかからないと思います。

⑨SWAG(ノベルティ)を効率よく手に入れよう

re:Inventでは、会場の各地でSWAG(ノベルティ)が配布されています。

パターンとしては、

- re:Inventに参加したら必ずもらえるもの(今回はパーカーと水筒)

- 特定の場所に行き、条件を満たせばもらえるもの

- 「基調講演で最初に入場した1000名限定」でもらえるTシャツ

- Expo(常設展示)の各ブースでもらえるステッカー、Tシャツなど

- Certificate Loungeに入場するともらえるロンT、靴下、バッジ

- etc

があります。

心がけておくこととしては、以下の3つで十分かと思います。

- Expoには早いタイミング(1or2日目)で行って、目当てのブースのノベルティをもらう

- 各日のKeynoteなどre:Inventの主要イベントはなるべく早めに会場に行く

- それ以外はもらえたらラッキーぐらいに考える(いちいち調べる暇がない)

Tシャツ、ステッカーなどエンジニアにとって嬉しいお土産が無料で手に入るので、効率よくお土産を手に入れていきましょう。

?ノベルティは引換券だけもらい、あとで引換所で現物をもらう形式のものも多いです⑩遊びの予定は到着日と金曜日に入れよう

せっかくラスベガスに来ているので、空いた時間にラスベガスならではのアクティビティを体験しておくと良いと思います。(例. カジノ、シルクドゥソレイユ鑑賞、グランドキャニオン観光など)

ただ、なんだかんだでre:Invent開催中は夜もエンジニア同士の交流イベントがあったりするので、24時とかに部屋に戻ってきて、次の日は朝8時半開始のKeynoteに行くために6時起き、というようになかなかハードスケジュールになりがちでした。

なので、個人的な予定は到着日の夕方〜夜か、re:Invent最終日の金曜日(この日はセッションは午前中までしかない)に入れると良いと思います。

まとめ

僕は今回がre:Invent初参加だったので、まだまだ最適化できる余地があるかも知れません。この記事が来年参加する方の参考になれば幸いです。

- 投稿日:2019-12-09T19:42:14+09:00

AWS Toolkit for Visual Studio CodeでVSCodeからAWS SAMアプリをデプロイする

はじめに

AWSでサーバーレスアプリをサクッと作る場合は、AWS SAM CLI等を使ってコマンドラインから構築することもできますが、AWS Toolkit for Visual Studio Codeを使って普段のエディタからも同じことができます。

Node.js、Java、Python、Goに対応しています。

さらにAWS Toolkitを使うとローカルでのデバッグ、テストも容易になります。

多少SAMコマンドも紹介しますが、AWS Toolkitを使って簡単なアプリ(API Gateway + Lambda)をデプロイするところまでやってみます。AWS SAMとは

https://aws.amazon.com/jp/serverless/sam/faqs/

AWS サーバーレスアプリケーションモデル (AWS SAM) は、サーバーレスアプリケーション構築用のオープンソースフレームワークです。迅速に記述可能な構文で関数、API、データベース、イベントソースマッピングを表現できます。リソースごとにわずか数行で、任意のアプリケーションを定義して YAML を使用してモデリングできます。

SAMテンプレートとはCloudFormationの拡張版です。

JSON、YAMLフォーマットで、AWSのサーバーレスリソースを記載します。

専用のコマンドラインツールが用意されていますが、デプロイする時はCloudFormationに対してデプロイされます。SAMに対応しているAWSリソースはこちら

https://docs.aws.amazon.com/ja_jp/serverlessrepo/latest/devguide/using-aws-sam.html#supported-resources-for-serverlessrepoAWS Toolkit for Visual Studio Codeとは

https://aws.amazon.com/jp/visualstudiocode/

AWS Toolkit for Visual Studio Code は、Visual Studio Code 用のオープンソースプラグインで、アマゾン ウェブ サービス上でのアプリケーションの作成、デバッグ、デプロイを容易にします。AWS Toolkit for Visual Studio Code を使用すると、AWS 上での Visual Studio Code を使用したアプリケーションの構築をより迅速に開始でき、生産性が向上します。このツールキットは、使用開始のサポート、ステップ実行によるデバッグ、および IDE からのデプロイを含む、サーバーレスアプリケーションの統合開発環境を提供します。

準備(環境構築)

・Mac、Windows、Linuxのいずれかを用意します。

・公式ドキュメントに従ってAWS CLI、AWS SAM、Dockerもインストールします。

・Visual Studio Codeをインストールします。

・VS CodeのExtensions (拡張機能)で使用する言語のランタイムSDK(Node.js、Java、Python、Go)とAWS Toolkit for Visual Studio Codeをインストールします。

・AWSアカウントと認証情報(IAMユーザーのアクセスキーシークレットキー)を取得して、AWS CLIにセットアップしておきます。

・SAMテンプレートやLambdaソースコードをアップロードするためのS3バケットを作成しておきます。手順

・VS CodeにAWS認証情報を設定

・アプリケーションの雛形作成

・実装

・ローカルデバッグ

・ローカル実行

・ローカルテスト

・テンプレート検証

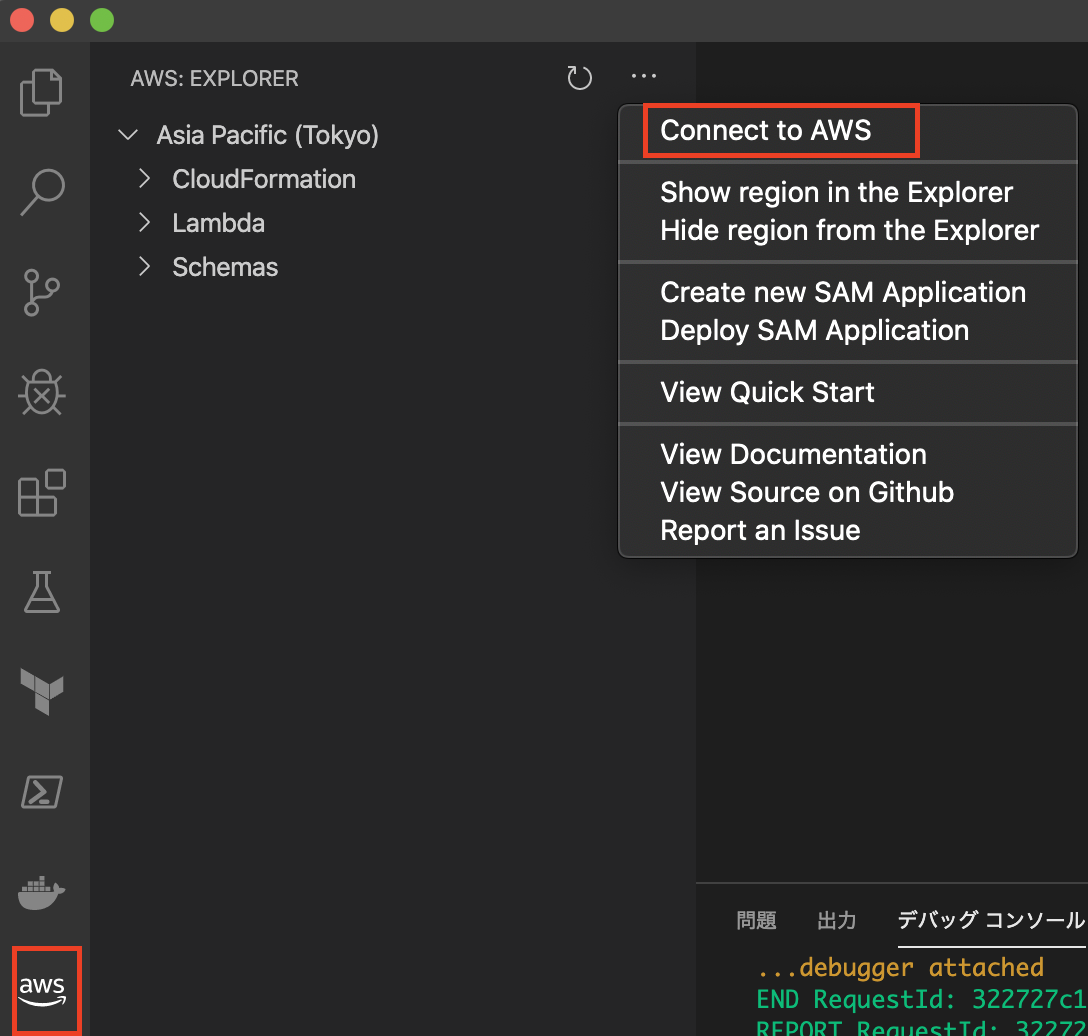

・デプロイVS CodeにAWS認証情報を設定

VS Codeを開き、左ペインにAWS Toolkitアイコンが追加されていることを確認します。

メニューから「Connect to AWS」を選択し、使用する認証情報のプロファイルを指定します。

アプリケーションの雛形作成

メニューから「Create new SAM Application」を選択し、ランタイム、ワークフォルダ、アプリ名を入力します。

Lambda Functionのソースコード、テストコード、SAMテンプレート(template.yaml)、READMEが自動生成されます。

ここからカスタマイズしていきます。

実装

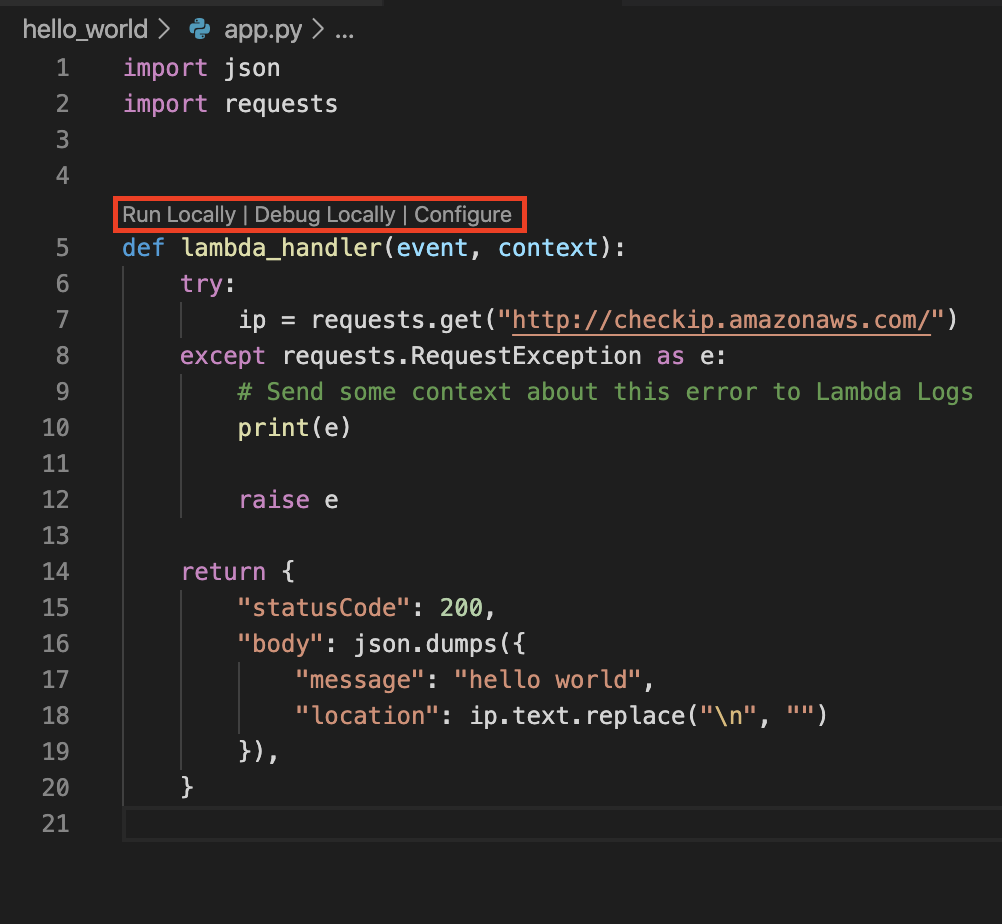

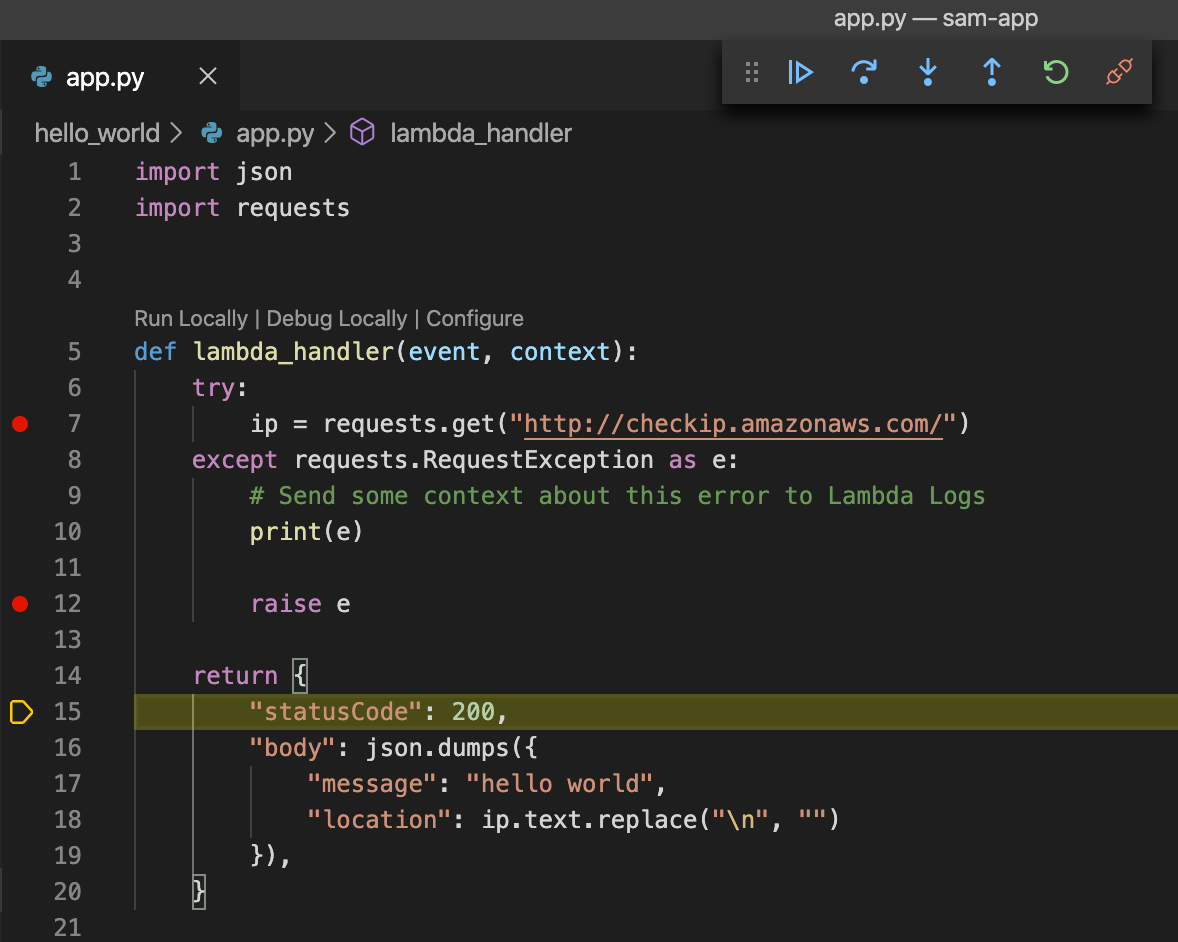

app.pyを開くと「Run Locally」「Debug Locally」「Configure」が表示されます。

デフォルトのコメントアウトを外します。(実行環境のIPアドレスを取得するロジックを追加します)

ローカル実行

ここでDockerを起動しておく必要があります。

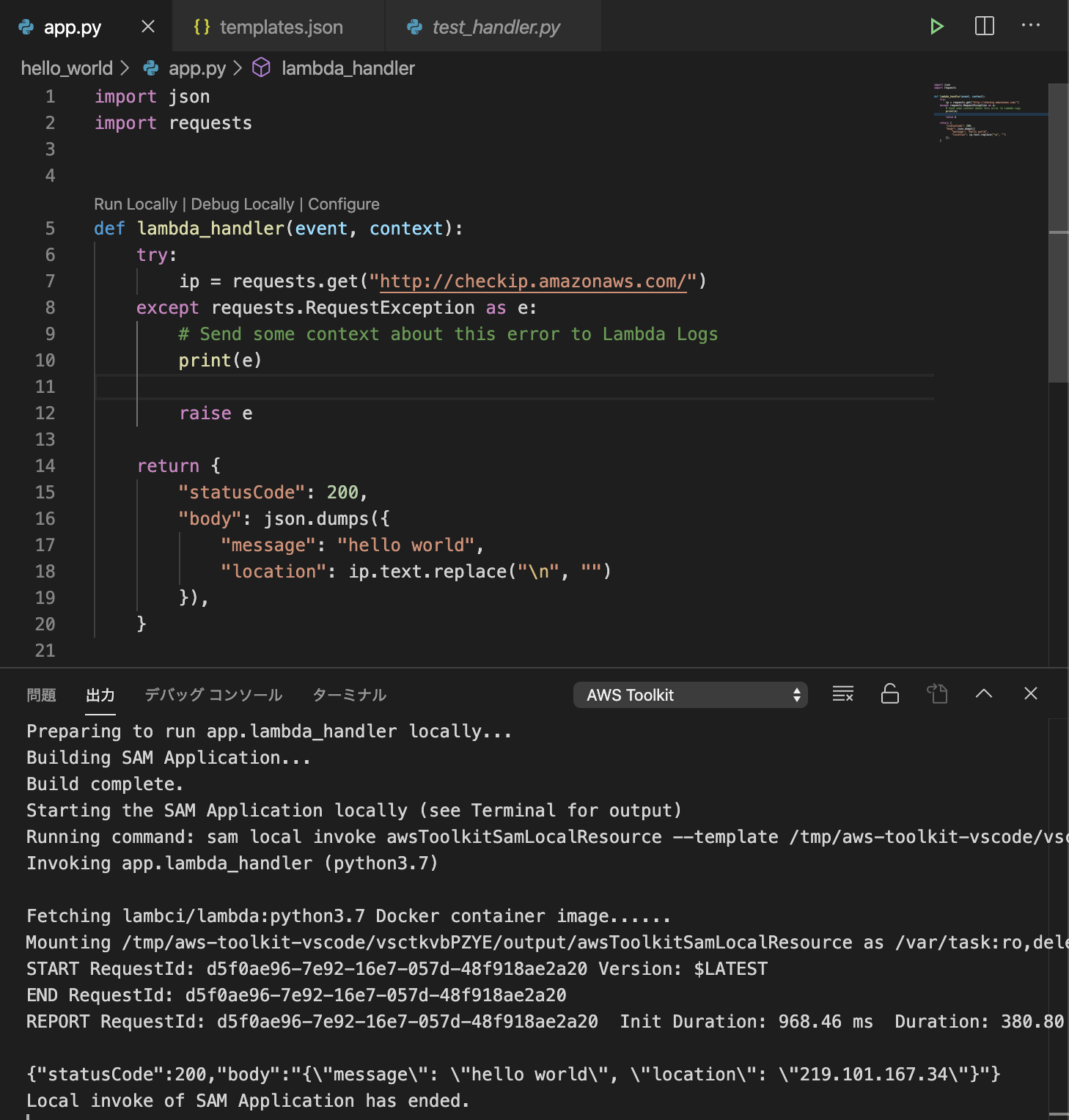

app.pyを開き、ブレークポイントを指定して「Run Locally」を選択します。

コンテナが起動し、しばらくすると結果が返ります。

実装したLambdaのコード(app.py)をDocker上で実行できました。

ローカルデバッグ

次にデバッグしてみます。

app.pyを開き、ブレークポイントを指定して「Debug Locally」を選択します。

このように簡単にLambdaをデバックできます。

「Configure」を選択して、パラメータのeventを編集することもできます。

ローカルテスト

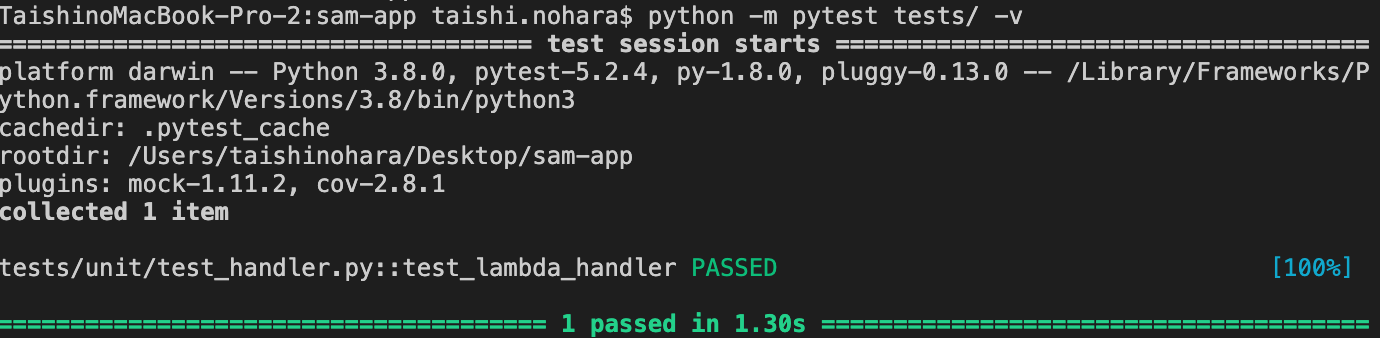

今回はPythonを選択したのでpipでpytestをインストールしておきます。

pip install pytest

以下コマンドをプロジェクト直下のターミナルから実行します。

python -m pytest tests/ -v

テンプレート検証

テストが終わったら、SAMテンプレート(template.yaml)の構文をコマンドで検証します。

ターミナルから下記コマンドを実行します。

sam validate

構文に誤りがあると怒られます。デプロイ

最後にデプロイします。

メニューから「Deploy SAM Application」を選択し、SAMテンプレートファイル名(template.yaml)、リージョン(ap-northeast-1)、準備したS3バケット名、CloudFormationスタック名を指定します。

するとデプロイが始まります。Starting SAM Application deployment... Building SAM Application... Packaging SAM Application to S3 Bucket: ${S3バケット名} with profile: saml Deploying SAM Application to CloudFormation Stack: sam-app with profile: saml Successfully deployed SAM Application to CloudFormation Stack: sam-app with profile: samlおめでとうございます。デプロイ成功です。

念の為、出力されたリソースもCloudFormationから取得してみます。

aws cloudformation describe-stacks --stack-name sam-app --output text

成功していれば、IAM Role、Lambda Function、API Gatewayのリソースが取得できます。最後にデプロイされたLambdaを実行してみましょう。

メニューからCloudFormaionの下にデプロイされたLambdaが表示されますので右クリックして「Invoke on AWS」を選択。

下のようにパラメータを設定して「Invoke」で実行して結果を確認します。

まとめ

いかがでしたでしょうか。

個人の開発環境としては十分ですね。AWS Toolkitを使うとコマンドラインに抵抗がある方でも簡単にSAMを使ってデプロイできます。

SAMのメリットはCloudFormationと同様にインフラをコード化することです。

SAMを使えばサーバーレスのアプリを簡単にコード化できるので、チーム開発でも捗りますね。

テストとデプロイのステップをパイプラインに組み込めば、簡単にCI/CD化も可能です。

AWS CDKもサポートしているようなので機会があればそちらもやってみたいと思います。

- 投稿日:2019-12-09T19:06:37+09:00

Now Available on Amazon SageMaker: The Deep Graph Library 和訳してみた

はじめに

今回は、Julien Simon 氏が2019年12月3日に投稿した「Now Available on Amazon SageMaker: The Deep Graph Library」の内容を翻訳し、まとめてみました。本記事と Deep Graph については下記リンク参照。

■リンク

Now Available on Amazon SageMaker: The Deep Graph Library

The Deep Graph LibraryNow Available on Amazon SageMaker: The Deep Graph Library

Deep Graph Library

Amazon SageMaker で、Deep Graph Library が利用できるようになったことを、発表します。

Deep Graph Library は、オープンソースライブラリです。特徴としては、グラフニューラルネットワーク(GNN)の実装を簡単に行うことができます。

ディープラーニングは、テキストやイメージ、あるいはビデオなどの複雑なデータから精巧なパターンを切り抜くことができます。しかし、全てのデータセットにディープラーニングが当てはまるとは限りません。グラフ表示で十分な場合もあります。その様なデータセットに対しては、畳込ニューラルネットワークや、回帰型ニューラルネットワークといった伝統的なニューラルネットワークアーキテクチャに替わる別のアプローチが必要となります。A Primer On Graph Neural Networks

グラフニューラルネットワーク(GNN)は、今日のマシンラーニングにおいて最もエキサイティングな開発の1つです。

GNN は、以下の様なデータセットの予測モデルのトレーニングに利用されます。

- グラフで関係性のある人間同士の繋がりを示しているソーシャルネットワーク

- グラフで顧客と商品の相互作用を示す推薦システム

- グラフで原子と結合でモデル化されチエル合成物質を示している化学解析

- グラフでIPアドレスとソースの疎通を示しているサイバーセキュリティ

等々、上記以外にも対象となるデータセットは沢山あります。

殆どの場合、これらのデータセットは膨大であるにも関わらず、十分にラベル化されていません。Introducing The Deep Graph Library

Deep Graph Library(DGL) は、2018年12月に、初めてリリースされました。DGL は Python オープンソースライブラリで、データセットに GNN の構築やトレーニング、そして評価を簡単に行うことができます。

DGL は、PyTorch や Apache MXNet といった有名なディープラーニングのフレームワーク上に構築されております。また、DGL 内に実装されているカッティングエッジモデルの数々を試すことも可能です。例えば、下記のコマンドを入力することで、グラフ畳み込みネットワーク(GCN)と、CORA データセットを使用したドキュメント分類モデルを簡単にトレーニングできます。$ python3 train.py --dataset cora --gpu 0 --self-loopDGL には、簡単にダウンロードし、実験できるデータセットが用意されております。DGL をインストールし、ローカルで利用することも可能ですが、AWS ではより簡単に利用できるよう、PyTorch および Apache MXNet の Deep Learning Containers に追加しました。これにより、どんな規模のモデルのトレーニングもデプロイもできます。

Using DGL On Amazon SageMaker

SageMaker の例のために Github リポジトリに例題を追加しております。そのうちの1つ、Tox 21 データセットを使用した分子毒性予測のシンプルな GNN トレーニングを簡単に紹介したいと思います。

- 取り組む内容

- 12 の異なるターゲット(生体細胞内の受容体など)に対して、新しい化合物の潜在的な毒性を把握すること

- データセットについて

- 8,000 ちょっとの化合物がデータセットにある

- 各化合物はグラフ(原子は頂点、原子結合はエッジ)としてモデル化されている

- 12回ラベル付けされている(1つのターゲットに1つのラベル)

GNNを使用し、マルチラベルバイナリ分類モデルを構築することで、候補分子の潜在的な毒性を予測できるようにします。

トレーニングスクリプトでは、下記のコマンドで DGL のコレクションから簡単にデータセットをダウンロードできます。from dgl.data.chem import Tox21 dataset = Tox21()同じ様に、DGL モデル zoo を使用することで、GNN 分類器を簡単に構築することができます。

from dgl import model_zoo model = model_zoo.chem.GCNClassifier( in_feats=args['n_input'], gcn_hidden_feats=[args['n_hidden'] for _ in range(args['n_layers'])], n_tasks=dataset.n_tasks, classifier_hidden_feats=args['n_hidden']).to(args['device'])残りのコードの大部分はバニラ PyTorch で、このライブラリに精通していれば、ベアリングを見つけることができるはずです。

Amazon SageMaker でこのコードを実行する場合は、SageMaker を 使用して、EstimatorDGL コンテナのフルネームとトレーニングスクリプトの名前をハイパーパラメーターとして渡すだけです。estimator = sagemaker.estimator.Estimator(container, role, train_instance_count=1, train_instance_type='ml.p3.2xlarge', hyperparameters={'entrypoint': 'main.py'}, sagemaker_session=sess) code_location = sess.upload_data(CODE_PATH, bucket=bucket, key_prefix=custom_code_upload_location) estimator.fit({'training-code': code_location}) <output removed> epoch 23/100, batch 48/49, loss 0.4684 epoch 23/100, batch 49/49, loss 0.5389 epoch 23/100, training roc-auc 0.9451 EarlyStopping counter: 10 out of 10 epoch 23/100, validation roc-auc 0.8375, best validation roc-auc 0.8495 Best validation score 0.8495 Test score 0.8273 2019-11-21 14:11:03 Uploading - Uploading generated training model 2019-11-21 14:11:03 Completed - Training job completed Training seconds: 209 Billable seconds: 209これで、S3 でトレーニング済みのモデルを取得し、それを使用して、実際の実験を実行することなく、多数の化合物の毒性を予測できました。

おわりに

Now Available on Amazon SageMaker: The Deep Graph Library の和訳は以上となります。

- 投稿日:2019-12-09T18:58:01+09:00

kinesisを利用した際のアンチパターン

パーソンリンクアドベントカレンダー11日目の投稿です。

こんにちは桑原です。kinesisを案件で使った際にサクッとうまく行かない構成で開発を行ったのでアンチパターンとしてメモしておきます。

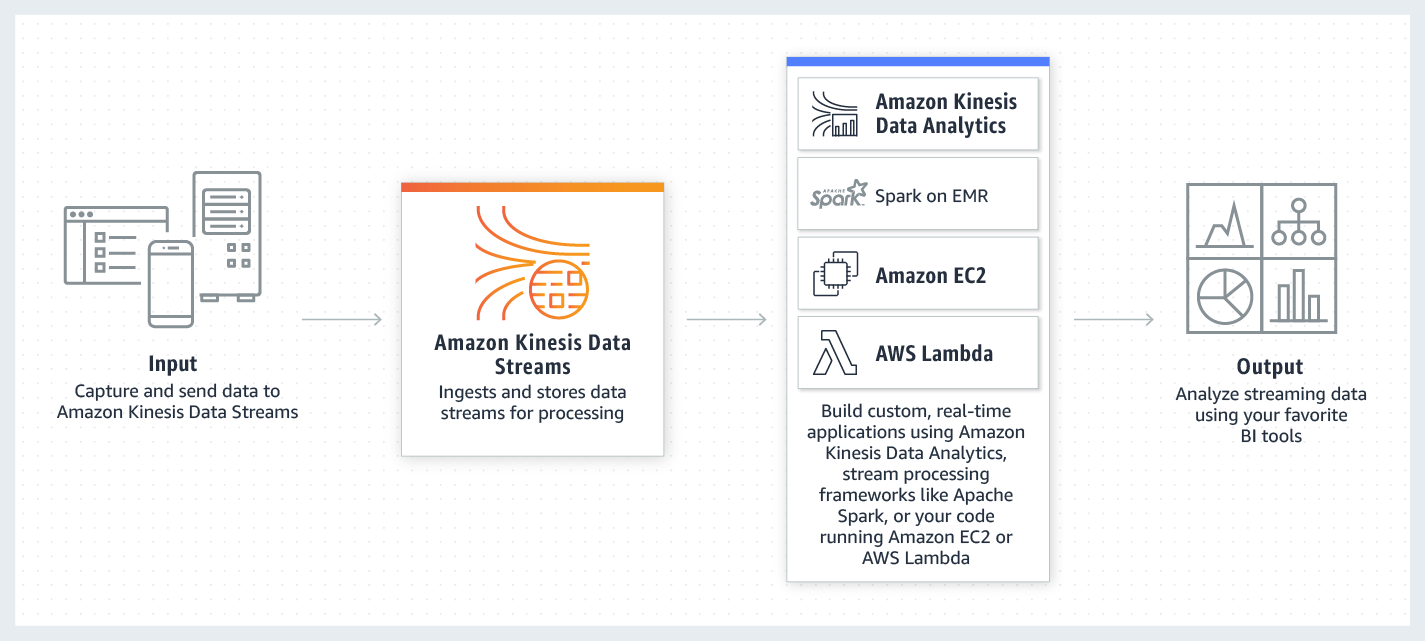

kinesisとは

まず初めにkinesisについて解説します。

ざっくりいうと膨大なデータをシャードという単位でまとめて別のシステム送信するサービスとなります。

送信先にはS3、Lambda、Firehoseなど様々なAWSのサービスへ連携が可能です。以下、AWS公式の解説です。

Amazon Kinesis でストリーミングデータをリアルタイムで収集、処理、分析することが簡単になるため、インサイトを適時に取得して新しい情報に迅速に対応できます。Amazon Kinesis は、アプリケーションの要件に最適なツールを柔軟に選択できるだけでなく、あらゆる規模のストリーミングデータをコスト効率良く処理するための主要機能を提供します。Amazon Kinesis をお使いになると、機械学習、分析、その他のアプリケーションに用いる動画、音声、アプリケーションログ、ウェブサイトのクリックストリーム、IoT テレメトリーデータをリアルタイムで取り込めます。Amazon Kinesis はデータを受信するとすぐに処理および分析を行うため、すべてのデータを収集するのを待たずに処理を開始して直ちに応答することが可能です。※https://aws.amazon.com/jp/kinesis/

仕組み

kinesisに連携可能なサービス

今回は案件で利用しようとした2つを紹介します。

Amazon Kinesis Data Firehose

Firehoseはkiensisからのデータを別のサービスへロードすることができます。

kinesis → Firehose → s3のような連携であればコンソールからの設定のみで実行可能です。

※https://aws.amazon.com/jp/kinesis/data-firehose/Amazon Kinesis Data Analytics

Analyticsはkinesisから受け取ったデータをリアルタイムで分析を行うことが可能です。

※https://aws.amazon.com/jp/kinesis/data-analytics/今回陥った事象

上記のkinesisに連携可能なサービス一覧に連携できない状態に陥りました。

kinsisに合わない仕様(AWSサポートお墨付き)

kinesisはデータを送信する際にレコード単位で処理できる想定ですが、今回の用件ではデータが圧縮されて送信される状態でした。

圧縮することでシャード数を削減し、料金を大幅に下げることが可能なためこの仕様を選択したとのことでした。(一理あります)

詳しい数字は出せないのですが計算上シャード数は10分の1程度まで下がり料金的にも大幅な削減となっていました。

しかし圧縮することで連携できないサービスがあることが判明しました。連携できないサービス

kinesisに連携可能なサービス一覧で記載した下記サービスに非対応の圧縮ファイルを用いることで意図した挙動で処理が実行されない状態でした。

マネージドサービスが使えずにとても悲しかったことを覚えています。

・Firehose

・Analytics(zipは対応しているようです)対応方法

Firehoseが利用できないことがわかったため、lambdaとfluentdを使ってkinesisからデータ取得を行っています。

それぞれの処理途中で解凍処理を実行しています。

現状では膨大なデータでの連携テストを実施できていないですが、秒間数千程度であれば処理途中での解凍は問題なく実行できています。

処理速度の問題でPythonからGoへ言語を変更するなどを行いました。今後起きる可能性がある未解決事項

kinesisの後続処理で解凍とリアルタイムでのデータ送信を行っているため、秒間数十万件というデータが流れてきた場合にkinesisと同じ速度でデータを流すことが可能なのかの検証が必要です。

スケールアウト可能な設計になっているのでkinesisで節約した分がここに乗る気がしています。まとめ

サービスにあった仕様で構築できれば公式のベストプラクティスに当てはまった開発もでき期間の短縮が可能だったと思います。

サービスには想定された使い方がありそこから外れると大変な目に合ったという体験談でした。

- 投稿日:2019-12-09T18:57:04+09:00

[AWS] re:Invent2019 の自分まとめ

概要

- re:Invent2019で発表された全てではありません

- 自社サービスで活用可能性がありそうなものを独自で抽出しています

- 全てを知る場合は

Whats' Newの確認をおすすめします新サービスにあるBeta/Previewについて

Amazon S3アクセスポイント

概要

- S3への新しいアクセス方法

- バケットポリシーの管理がアクセスポイント単位で可能になる

ユースケース

- S3アクセスポイントのうれしい点を自分なりの理解で解説してみる

- 複数のアクセス設定をバケットポリシー1つで管理していたものをポリシー別にアクセスポイントを作成して煩雑さを取り除く

- バケットポリシーの設定ミスの影響を最小限に留めることができる

- VPC内アクセスに限定するアクセスポイントを発行できセキュリティ向上

コスト

- なし

AWS Compute Optimizer

概要

- 機械学習ベースの最適なEC2インスタンスをオススメしてくれるサービス

- M、C、R、T、Xインスタンスに対して有効

ユースケース

- EC2インスタンスの最適化を行いたいときの判断材料として利用する

コスト

- Computeリソース(おそらくEC2??)

- CloudWatchのモニタリング料金

どれぐらいのコストがかかるか未知数(そんなかかんない?)

API Gateway HTTP API (Beta)

概要

- REST APIよりも安く利用可能です(最大71%OFF)

- APIプロキシ機能のみ提供します

- LambdaやHTTPバックエンドにプロキシするAPIを構築するために最適化されサーバレスに最適

- OIDC、OAuth2をサポート

- CORSもOK

ユースケース

- Lambdaのみで構築するシンプルなAPI

- HTTPのプロキシAPI

コスト

- REST APIと比較して最大71%OFF

Amazon CodeGuru(Preview)

概要

- 自動化コードレビュー

- 負荷の高い、コストのかかるコードを見つけ修正・改善の提案を行ってくれる

- アプリケーションパフォーマンス向上に役立つ

- CodeCommitにリポジトリがり関連付けることで使用可能

- 東京リージョンはまだ(2019年12月5日現在)

ユースケース

- コード改善に利用する

コスト

- 1か月にスキャンされる

コード100行あたり0.75ドル- 200行のコードを100プルリクエストした場合

- 200/100 * 0.75 * 100 = $150

- 結構高い!

Fargate Spot

概要

- EC2スポットインスタンスのFargate版

- 最大で70%オフ

ユースケース

- フォールトトレラントな箇所

- 一部が落ちても問題なく可動するシステム

コスト

- 1時間あたりのvCPU単位

- $0.015168(通常:$0.05056)

- 1時間あたりのGB単位

- $0.001659(通常:$0.00553)

Amazon Elasticsearch Service UltraWarm(Preview)

概要

- ESの最大懸念点であるコスト改善

- 格納データを高頻度、低頻度に分けることでコスト削減される

- 高頻度:EBS

- 低頻度:S3

- 最大900TBものHot-Warm層を設けることで90%ものコスト削減を実現する

- バージョン6.8から利用可能

- 新規ドメインに適用可能

- 東京リージョンはまだ(2019年12月5日現在)

ユースケース

- アクセス頻度に偏りがあるES

- UltraWarmからのデータ取得性能が許容可能

- コストに悩んでいる

コスト

- GBあたりのコストを最大90%削減する

AWS Step Functions Expressワークフロー

概要

- StepFunctionsの新しいワークフロー

- 従来のワークフローよりも高スループットと低コストを実現する

- 100,000/秒を超える呼び出しをサポート

- 従来:2,000/秒

- 従来のワークフローとかなり仕様が異なる

ユースケース

- IoTなどの高スループットが必要な時

- 従来ワークフローの性能が不要でコスト削減したい時

- 実行時間制限が5分なので超短期間処理に使用する

コスト

- 実行回数、実行時間、メモリ消費量に基づく料金が設定されている

- 従来は状態遷移毎に対して設定

AWS Identity and Access Management(IAM)Access Analyzer

概要

- IAM管理サービス

- IAMからワンクリックぽちっ!で使える

- ポリシーが意図したサービスへのアクセスのみ提供することを監視

- ポリシーの追加、更新を検知できる

- AWS Security Hubはこのサービスと統合される

ユースケース

- セキュリティ向上

コスト

- なし

Access Analyzer for Amazon S3

概要

- S3のアクセスポリシー監視サービス

- 不要な公開バケットを生み出さないようにする

ユースケース

- セキュリティ向上

コスト

- なし

Amazon CloudWatch Contributor Insights(Preview)

概要

- DynamoDBテーブルのキーとトラフィックの傾向をひと目で確認できる診断サービス

- 頻繁にアクセスされるキーの特定に役立つ

ユースケース

- DynamoDBの最適化

コスト

- 1ルールあたり$0.50

- ルールに一致する100万イベントごとに$0.30

AWSコンソールからリージョンにすばやくアクセス

概要

- AWSコンソール右上のリージョン選択にリージョンコード(ap-northeast-1とか)が表示されるようになった

ユースケース

- なし

コスト

- なし

Amazon Athena ユーザー定義関数(UDF)のサポート(Prevew)

概要

- ユーザー定義関数が利用可能になった

- クエリを発行するとJavaで記述したLambdaが起動してレコードに対する処理を実行可能

- データ圧縮、データ加工などなど

- 1クエリで取得できる複数レコードに対して1Lambdaが起動する

- 東京リージョンはまだ(2019年12月5日現在)

- バージニア北部のみ

ユースケース

- クエリ結果取得と同時に処理が必要な場合

コスト

- Lambda起動分のコスト

AWS for Fluent BitがAmazon Kinesis Data Streamsをサポート

概要

- FluentBitからKinesisDateStreamsへログ送信できるようになった

- FluentBit:ログ転送ツール

- ログをまとめて別の場所にポンッとできたり

ユースケース

- Kinesisへログを投げてログ解析基盤を構築する

- CloudWatchLogsはコスト高いので別ログ基盤を構築する

コスト

- なし

AWS タグポリシー

概要

- タグ付け管理の支援を行う

- 指定できるタグを指定したりタグに指定できる値を制限したり出来る

- AWS Organizationで一元管理できる

ユースケース

- コスト管理用タグのつけ間違えやつけ忘れを監視する

コスト

- なし

AWS Lambda非同期呼び出しの宛先をサポート

概要

- Lambda非同期呼び出し時に結果を受け取る宛先を指定できるようになった

- 別のLambda

- SNS

- SQS

- EventBridge(CloudWatchEvents)

ユースケース

- 非同期呼び出ししたLambdaの結果を別処理で利用したい場合

コスト

- なし

AWS Lambda Provisioned Concurrency

概要

- Lambdaでコールドスタート対策が公式にサポートされた

- AutoScalingを利用してProvisionedする値を動的変更することも可能

ユースケース

- 初期起動時からシビアなレスポンスを必要とする処理

コスト

AWS Lambda Supports Amazon SQS FIFO as Event Source

概要

- LambdaのイベントトリガーにSQSのFIFOを指定することが出来るようになった

- 順序保証されたキューの取得が可能

ユースケース

- メッセージ取得に順序保証が必要な処理

コスト

- なし

Amazon CloudWatch ServiceLens

概要

- アプリケーションの健全性、パフォーマンス、可用性を1か所で視覚化および分析できる新しい機能

- CloudWatchメトリクス、ログ、X-Rayからのトレースを結びつけてアプリケーションの依存関係をビューする

- AWS X-Rayを有効にすることで利用可能

ユースケース

- よりワークロードに寄せたモニタリングの実施

- マイクロサービスなどの分散された処理の一元モニタリング

コスト

- ServerLens自体はコストなし

- 投稿日:2019-12-09T18:47:26+09:00

Serverless framework x CircleCI でAWS lambdaのローカル開発環境構築

Linc’well Advent Calendar10日目の記事です。

当社が展開するクリニックグループの CLINIC FORの予約システム で、認証機能の一部にAWS Cognitoへの移行を進めております。

予約システム全体としてはモノリシックなRailsアプリケーションで開発をしてきたのですが、AWS CognitoをRailsアプリケーションの上に被すように実装する必要がり、連携をするためにAWS CognitoのTriggerをlambdaで実装する必要がでてきました。

この記事では、ローカル環境でのlambda開発、テストをどう構築したかをまとめます。

lambda 開発環境構築

今回は、Serverless Frameworkを使って開発を進めます。Frameworkのinstallとprojectを作成します。

npm install -g serverless serverless create --template aws-nodejs --name cognito-triggers --path cognito-triggers cd cognito-triggerslambda の依存パッケージをインストール

RailsアプリケーションにAWS Cognitoを連携させるために、http clientとして

axiosを使います。npm init npm install axios --savelambda のコードを書く

このは、AWS Cognitoのサインアップ前 Lambda triggerです。AWS Cognitoは、自前のバックエンド等と連携するため、沢山のTriggerを提供しています。

ご興味あるかたは、こちらをご覧ください。

サインアップ前に、入力されたemailが、登録済 or 未登録 か判定して、登録済であればCognitoへ登録、未登録であればCognitoへ登録しない仕様の実装です。

pre-sign-up.js'use strict'; const axios = require('axios'); async function exists(server, data, callback) { let url = 'https://' + server + '/api/endpoint/exists'; const config = { headers: { "Content-Type": "application/json" }, responseType: 'json' }; await axios.get(url, {params: data}, config) .then(response => { console.log('response:', response.data); callback(null, response.data); }) .catch(function (error) { callback(error); }); } module.exports.exec = async (event, context, callback) => { console.log('start pre authentication user:', event.userName); console.log(event) let userAttributes = event['request']['userAttributes'] let email = userAttributes["email"]; let rails_server_url = process.env.API_HOST_NAME; await exists(rails_server_url, { email: email }, (err, response) => { if (err) { return context.fail("Connection error"); } // ユーザーの 登録済 or 未登録判定 if (response.user_exists == false) { // 未登録 console.log('user not exists:', email); context.succeed(event); } else { // 登録済 console.log('user exists:', email); context.fail("user exists"); } }); };lambda をテストする

Lambdaをテストするために、下記2つをmockする必要あります。

- AWS Cognitoのcontext

- axios

これらをmockしてテストします。

テストに必要なパッケージをインストール

テストフレームワークとして

jest、AWS Cognitoのmockとしてaws-lambda-mock-context serverless-prune-pluginもインストールします。npm install jest aws-lambda-mock-context serverless-prune-plugin --save-devevent data の準備

加えて、AWS CognitoがTriggerで送信してくるeventも準備する必要あります。

pre-sign-up-event-data.jsmodule.exports = { testEvent: { "userName": "test@example.com", "request": { "userAttributes": { "email": "test@example.com" } } } };テストコード

pre-sign-up.test.js'use strict' const { exec } = require('./pre-sign-up'); const event = require('./pre-sign-up-event-data'); // mock const context = require('aws-lambda-mock-context'); const axios = require('axios'); jest.mock('axios'); describe('user-migration.js.exec()', () => { describe('user_status: CONFIRM', () => { describe('user not exists', () => { it('return event', async () => { // axios mock axios.get.mockResolvedValue({ data: {user_exists: false} }); const ctx = context(); await exec(event.testEvent, ctx, function () { }); // AWS Cognito の context判定 await ctx.Promise .then(result => { expect(result).toBe(event.testEvent); }); }); }); describe('user exists', () => { it('through error', async () => { // axios mock axios.get.mockResolvedValue({ data: {user_exists: true} }); const ctx = context(); await exec(event.testEvent, ctx, function () { }); // AWS Cognito の context判定 await ctx.Promise .catch(err => { expect(err).not.toBeNull(); }); }); }); }); });テスト実行

ローカル環境でテスト実行できるはずです。

npx jestlambda の deploy

dev, stg, prd と deploy をしたいと考えると、

sls deploy -v --stage devこんな感じでdeployできると嬉しい。

stage別の設定ファイルを作成する

- environments/dev.yml

- environments/stg.yml

- environments/prd.yml

のように配置する。内容は下記の通り。

environments/dev.ymlprofile: your_aws_profile_name region: aws_region_name functionNamePrefix: function-prefix- apiHostName: your-host-name.co.jpserverless.yml の編集

sls deploy -v --stage devから環境依存部分を解決できるように変数を展開する。

serverless.ymlservice: cognito-triggers provider: name: aws runtime: nodejs12.x stage: ${opt:stage} profile: ${self:custom.environments.${opt:stage}.profile} region: ${self:custom.environments.${opt:stage}.region} environment: API_HOST_NAME: ${self:custom.environments.${opt:stage}.apiHostName} plugins: - serverless-prune-plugin custom: prune: automatic: true number: 5 environments: dev: ${file(./environments/dev.yml)} stg: ${file(./environments/stg.yml)} prd: ${file(./environments/prd.yml)} functions: pre-sign-up: name: ${self:custom.environments.${opt:stage}.functionNamePrefix}cognito-trigger-pre-sign-up handler: pre-sign-up.exec user-migration: name: ${self:custom.environments.${opt:stage}.functionNamePrefix}cognito-trigger--user-migration handler: user-migration.exec post-authentication: name: ${self:custom.environments.${opt:stage}.functionNamePrefix}cognito-trigger--post-authentication handler: post-authentication.exec post-confirmation: name: ${self:custom.environments.${opt:stage}.functionNamePrefix}cognito-trigger--post-confirmation handler: post-confirmation.execCIrcleCI で継続的にtest実行するための設定

詳細は割愛しますが、↓のように、install, test 実行を追加。

.circleci/config.yml: steps: - run: name: install dependencies for lambda/cognito-triggers command: npm install working_directory: lambda/cognito-triggers : - run: name: run tests for lambda/cognito-triggers command: npm test working_directory: lambda/cognito-triggers :まとめ

こんな感じで、ローカル環境での開発、テスト、テスト後のDeployまで一気通貫できました。さらに良いプラクティスがあればフィードバック頂けたら幸いです!

- 投稿日:2019-12-09T18:30:56+09:00

Amazon RDS Proxy with AWS Lambda を試してみる

先日の re:Invent で RDS Proxy がプレビュー版ですが発表されました。

AWS Lambda は水平スケールするため RDS と相性が良くないと常々言われてきましたが、この機能でそれが解消されるのでしょうか?というわけで実際機能を試してみようと思います。

リソース作成

テスト用のVPC、RDS、Lambda Function、RDS Proxy を作成します

VPC, RDS 作成

今回 VPC、RDS はさくっと CloudFormation で作成

https://github.com/kobarasukimaro/rds-proxy-test/blob/master/cfn/rds-proxy-sample.ymlRDS の設定

パラメータグループで

max_connectionを 20 に設定しています。RDS Proxy 作成

RDS Proxy は画面から作成します。 awscli でも

1.16.300以上でしたら作成できます。以下のような感じで作成しました。サブネットが空になってますがちゃんと設定しています。関連付けるデータベースのサブネットが自動的にサジェストされるのであまり迷うことはないかと思います。

シークレットはこの画面から作成しても候補に出てこないで予め作っておいたほうが良いかも。Lambda 作成

Lambda は Serverless Framework で作成します。

sls deploy --stage xxxテスト用コード

Python で簡単に作成

lambdaimport mysql.connector DB_USER = os.environ["DB_USER"] DB_PASSWORD = os.environ["DB_PASSWORD"] DB_HOST = os.environ["DB_HOST"] DB_NAME = os.environ["DB_NAME"] def execute_query(event): config = { 'user': DB_USER, 'password': DB_PASSWORD, 'host': DB_HOST, 'database' : DB_NAME, } cnx = mysql.connector.connect(**config) cursor = cnx.cursor() query = ("SELECT SLEEP(10)") cursor.execute(query) def lambda_handler(event, context): execute_query(event)Lambda Function に RDS Proxy を登録

しなくても Proxy に接続できました。

↓に Proxy を登録すると IAM ロールが作られるので、 IAM 認証必須の場合に必要なのかもしれません。試してみる

最大コネクションが7個ある RDS で、 10秒スリープする Lambda Function を同時に 10並列で実行してみます

実行の前に

RDS に設定した

max_connectionは 20 ですが、

RDS 自体がコネクション 4個と RDS Proxy が 8個確保していて、さらにテスト中はコネクションの様子を見るためにコンソールから1個コネクションを使っているため実質的に Lambda が使えるコネクションは 7個となります。processlistMySQL [test]> show processlist; +-----+---------------+---------------------+------+---------+------+-------------+------------------+ | Id | User | Host | db | Command | Time | State | Info | +-----+---------------+---------------------+------+---------+------+-------------+------------------+ | 2 | rdsproxyadmin | xxx.xxx.xxx.xxx:xxxx | NULL | Sleep | 0 | cleaning up | NULL | | 3 | rdsproxyadmin | xxx.xxx.xxx.xxx:xxxx | NULL | Sleep | 0 | cleaning up | NULL | | 4 | rdsproxyadmin | xxx.xxx.xxx.xxx:xxxx | NULL | Sleep | 0 | cleaning up | NULL | | 5 | rdsproxyadmin | xxx.xxx.xxx.xxx:xxxx | NULL | Sleep | 0 | cleaning up | NULL | | 6 | rdsproxyadmin | xxx.xxx.xxx.xxx:xxxx | NULL | Sleep | 0 | cleaning up | NULL | | 9 | rdsadmin | localhost | NULL | Sleep | 1 | cleaning up | NULL | | 11 | rdsadmin | localhost | NULL | Sleep | 0 | cleaning up | NULL | | 55 | rdsadmin | localhost | NULL | Sleep | 14 | cleaning up | NULL | | 56 | rdsproxyadmin | xxx.xxx.xxx.xxx:xxxx | NULL | Sleep | 0 | cleaning up | NULL | | 57 | rdsproxyadmin | xxx.xxx.xxx.xxx:xxxx | NULL | Sleep | 0 | cleaning up | NULL | | 67 | rdsadmin | localhost | NULL | Sleep | 34 | cleaning up | NULL | | 122 | rdsproxyadmin | xxx.xxx.xxx.xxx:xxxx | NULL | Sleep | 0 | cleaning up | NULL | | 124 | admin | xxx.xxx.xxx.xxx:xxxx | test | Query | 0 | starting | show processlist | +-----+---------------+---------------------+------+---------+------+-------------+------------------+ 13 rows in set (0.01 sec)Proxy なし

まずは今まで通り、普通に RDS に接続した動作を試してみます

実行

Serverless Framework でローカルから10回実行

lambdainvoke$ for ((i=0; i<10; i++)); do serverless invoke --function proxy-test --stage xxx -r ap-northeast-1 &; done結果

CloudWatch で結果を見てみると、10回中 3回失敗しているのを確認できます

CloudWatch Logs を見ると

Too many connectionsが発生していたので想定通りの挙動となりますerror$ aws logs get-log-events --log-group-name /aws/lambda/xxxxxxxxx --log-stream-name "2019/12/10/[\$LATEST]xxxxxxxxxxxx" <中略> [ERROR] OperationalError: 1040 (08004): Too many connections <中略>Proxy あり

DB の接続先を RDS Proxy に変更して試してみます

実行

先ほどと同じように Serverless Framework でローカルから10回実行

lambdainvoke$ for ((i=0; i<10; i++)); do serverless invoke --function proxy-test --stage xxx -r ap-northeast-1 &; done結果

CloudWatch で結果を見てみると、10回中 全て成功しているのを確認できます

Duration を見てみると Max が約 20秒、 Min が約 10秒となってるので、max connection からあぶれたコネクションは空きが出るまで待っているものと思われます

ログも見てみましたが、 20秒かかっている実行はコネクションで待っているのが確認できます(赤枠がコネクション待ち)

RDS Proxy が想定通りの役割を果たしてくれています。 Lambda + RDS 使う場合の大きな心配事が一つ解消されるので GA になるのが楽しみですね。

ハマりどころ

CloudFormation から作成したシークレットだとエラー

最初 CloudFormation から RDS 用のシークレットを作成して RDS Proxy で読み込んでみたのですが、

Client authentication failed for user "{DBユーザー名}" with auth-plugin "mysql_native_password" and TLS on. Reason: Invalid credentials.というエラーが出てコネクションが張れませんでした。

画面からシークレットを作成した場合は上手くいったので、 CloudFormation 側で何か足りないものがあったとは思いますが原因は今の所不明です。Lambda でコネクションするときに Too many connections が出てしまう

これはテスト用にコネクション数の設定をいじっていたのが原因だったのですが

max_connectionを 1 や 10 に設定したところ、 RDS と RDS Proxy がコネクションを確保するのに気づかなかったので、そっちの確保が優先されて Lambda からコネクションが張れませんでした。 RDS のデフォルトのコネクション数で使う場合には全く問題はないかと思います。設定は正しいのに Lost connection が出てコネクションが張れない

リソースは全て構築したしコネクション数の設定も問題ないし、さあ試そうと思ったところ、 Lambda で

[ERROR] InterfaceError: 2055: Lost connection to MySQL server at '{RDS Proxy のDNS}:3306', system error: 8 EOF occurred in violation of protocol (_ssl.c:1076)というエラーが出てコネクションできませんでした。

どうやらmysql-connector-pythonのバージョンが原因で、8.0.17だとこのエラーが発生するようです。

また、Python 3.7 でこの事象を確認してます。 3.8 では未確認です。やり残し

- フェイルオーバーの速度比較

- RDS 直と Proxy のレイテンシー比較

- Python3.8 と mysql-connector-python >= 8.0.17 が動作するかどうか

- Lost connection の原因

コード

今回試したコード一式はこちら

https://github.com/kobarasukimaro/rds-proxy-test

- 投稿日:2019-12-09T18:01:15+09:00

AWS基礎

AWSに関わることになったので、基本的なキーワード等について簡単にメモる。

最低限のキーワードをピックアップしているため、その他の気になるキーワードや詳細解説についてはAWS公式サイトを参照ください。

AWSのアカウント

AWSにはAWSアカウントとIAMユーザーと呼ばれる2種類のアカウントがあります。

AWSアカウントとは、AWSサインアップするときに作成されるアカウントのことです。このアカウントでは、AWSアカウントの全てのサービスをネットワーク上のどこからでも操作できる権限を持っているため、ルートアカウントとも呼ばれています。

非常に危険なアカウントであるため、取り扱いには十分注意する必要があります。従って、日常的なタスクには、それが管理者タスクであっても、ルートユーザーを使用しないことが推奨されており、ルートユーザーは最初のIAMユーザーを作成するためだけに使用し、それ以外の操作はIAMユーザーを利用するというのがベストプラクティスとされています。

IAMユーザーについては、別途後述します。

リソース

リソースとは、S3のバケット、オブジェクト、EC2インスタンス等AWS上のリソースのことを指します。ARNによってリソースを特定できます。

ARN(Amazon Resource Name)

Amazon リソースネーム (ARN) は、AWS リソースを一意に識別します。IAM ポリシー、Amazon Relational Database Service (Amazon RDS) タグ、API コールなど、明らかに全 AWS に渡るリソースを指定する必要がある場合、ARN が必要です。

AWS Organizations

AWS Organizations は、作成し一元管理する組織に、複数の AWS アカウントを統合するためのアカウント管理サービスです。AWS Organizations には、利用者の予算、セキュリティ、コンプライアンスのニーズをより適切に満たすアカウント管理および一括請求機能が備わっています。組織の管理者は、組織内にアカウントを作成したり、既存のアカウントを組織に招待して参加させることができます。

IAM(Identity and Access Management)

IAMでは、AWS のサービスやリソースへのアクセスを安全に管理できます。IAM を使用すると、AWS のユーザーとグループを作成および管理し、アクセス権を使用して AWS リソースへのアクセスを許可および拒否できます。

つまり、「誰が」「どのAWSサービスの」「どのリソースに対して」「どんな操作を」「許可する(許可しない)」という情報を定義することが可能となります。

IAMポリシー

IAMではポリシーによって「Action(どのサービスの)」「Resource(どういう機能や範囲を)」「Effect(許可 or 拒否)」という3つの大きなルールに基づいてAWSの各サービスを利用するうえでのさまざまな権限をせっていします。

AWSが最初から設定しているポリシーをAWS管理ポリシーといい、各ユーザーが独自に作成したポリシーをカスタマー管理ポリシーといいます。作成されたポリシーは、ユーザー、グループ、ロールに付与することができます。

使い分けとしては、AWS管理ポリシーで基本的な権限を付与し、カスタマー管理ポリシーでIPアドレス制限などの成約をかけるといった方法があります。

※対象ごとに作成・付与するインラインポリシーと呼ばれるポリシーも存在するが、管理が煩雑になるので基本的には利用しない方向がよいが、一時的に個別のユーザーに権限を付与する時に利用するといった方法がある。

IAMユーザー

IAMユーザーは、AWSの各利用者に1つずつ与えられる、AWSを利用するための認証情報(ID)です。利用者がAWSマネジメントコンソールにログインして操作するときや、CLI(後述)を利用してAWSを操作するときに使用します。

各IAMユーザーに対して、操作を許可する(しない)サービスを定義することができ、各IAMユーザーの権限を正しく制限することで、AWSをより安全に使用することができます。

IAMグループ

一方、グループは同じ権限を持ったユーザーの集まりです。グループは、AWSへのアクセス認証情報は保持しません。認証はあくまでユーザーで行い、グループは認証されたユーザーがどういった権限(サービスの利用可否)を持つかを管理します。

グループの目的は権限を容易に、かつ、正確に管理することです。複数のユーザーに同一の権限を個別に与えると、権限付与の過不足等、ミスが発生する確率が高くなります。

ユーザーとグループは多対多の関係を持つことができるので、1つのグループに複数のユーザーが属することはもちろん、1つのユーザーが複数のグループに属することもできます。

ただし、グループを階層化することはできないので、グループで一定の権限をまとめておいて、ユーザーに対して必要なグループを割り当てる運用が望ましいです。

IAMロール

ロールは永続的な権限(アクセスキー、シークレットアクセスキー)を保持するユーザーとは異なり、一時的にAWSリソースへアクセス権限を付与する場合に使用します。

ロールを定義することで実現できることのひとつに、クロスアカウントアクセスがあります。複数のAWSアカウント間のリソースを1つのIAMアカウント(IAMユーザー)で操作したい場合、ロールを定義して必要なAWSリソースに対するアクセス権限を一時的に与えることで実現できます。

AWS CLI(Command Line Interface)

AWS コマンドラインインターフェース (CLI) は、AWS サービスをコマンドラインで操作することができる統合ツールです。基本的にはAWSマネジメントコンソールとほぼ同等の操作が可能。そのため、コンソール画面から行っていた操作をプログラムに組み込んだり、バッチ化することでAWSサービスをよりプログラマブルに利用することが可能になります。

MFA(Multi-Factor Authentication:多要素認証・2段階認証)

AWSアカウントもIAMユーザーもAWSマネジメントコンソールにログインする時は、IDとパスワードを必要とします。しかし、AWSアカウントや重要な権限を持つIAMユーザーは、これだけの認証では不十分です。

AWSではIDとパスワードに加えて、ワンタイムパスワードを使った多要素認証(MFA)に対応しています。

Amazon EC2(Amazon Elastic Compute Cloud)

Amazon EC2は、AWS クラウドでサイズが変更できるコンピューティングキャパシティーを提供します。Amazon EC2 の使用により、ハードウェアに事前投資する必要がなくなり、アプリケーションをより速く開発およびデプロイできます。Amazon EC2 を使用して必要な数 (またはそれ以下) の仮想サーバーを起動して、セキュリティおよびネットワーキングの設定と、ストレージの管理を行います。Amazon EC2 では、要件変更や需要増に対応して迅速に拡張または縮小できるため、サーバートラフィック予測が不要になります。

Amazon S3(Amazon Simple Storage Service)

Amazon S3 はインターネット用のストレージサービスです。また、ウェブスケールのコンピューティングを開発者が簡単に利用できるよう設計されています。

Amazon S3 のウェブサービスインターフェイスはシンプルで、いつでも、ウェブのどこからでも容量に関係なくデータを格納および取得できます。これにより、すべての開発者が、スケーラブルで信頼性が高く、かつ高速で安価なデータストレージインフラストラクチャを利用できるようになります。このインフラストラクチャは、Amazon が使用しているウェブサイトのグローバルネットワークと同じものです。このサービスの目的は、規模の拡大や縮小のメリットを最大限に活かし、開発者に提供することです。

AWS Cloud Trail

AWS CloudTrail は、AWS アカウントのガバナンス、コンプライアンス、および運用とリスクの監査を行えるように支援する AWS のサービスです。ユーザー、ロール、または AWS のサービスによって実行されたアクションは、CloudTrail にイベントとして記録されます。イベントには、AWS マネジメントコンソール、AWS Command Line Interface、および AWS SDK と API で実行されたアクションが含まれます。

CloudTrail は、作成時に AWS アカウントで有効になります。AWS アカウントでアクティビティが発生した場合、そのアクティビティは CloudTrail イベントに記録されます。

AWS アカウントアクティビティの可視性は、セキュリティと運用のベストプラクティスにおける重要な側面です。CloudTrail を使用して、AWS インフラストラクチャ全体のアカウントアクティビティを表示、検索、ダウンロード、アーカイブ、分析、応答できます。アクションを実行したユーザーやアプリケーション、対象のリソース、イベントの発生日時、およびその他の詳細情報を識別して、AWS アカウントのアクティビティの分析と対応に役立てることができます。

Route53

Amazon Route 53 は、可用性と拡張性に優れたドメインネームシステム(DNS)ウェブサービスです。Route 53 を使用すると、ドメイン登録、DNS ルーティング、ヘルスチェックの 3 つの主要な機能を任意の組み合わせで実行できます。

Terraform

HashiCorpが作っているツールで、インフラをコード化(Infrastructure as Code)するために利用する。

こちらは別途解説(予定)

- 投稿日:2019-12-09T17:59:20+09:00

AWS re:Invent 2019で発表【Amazon SageMaker Studio】

AWS re:Invent 2019で新たなサービスがドドン!と発表されました!

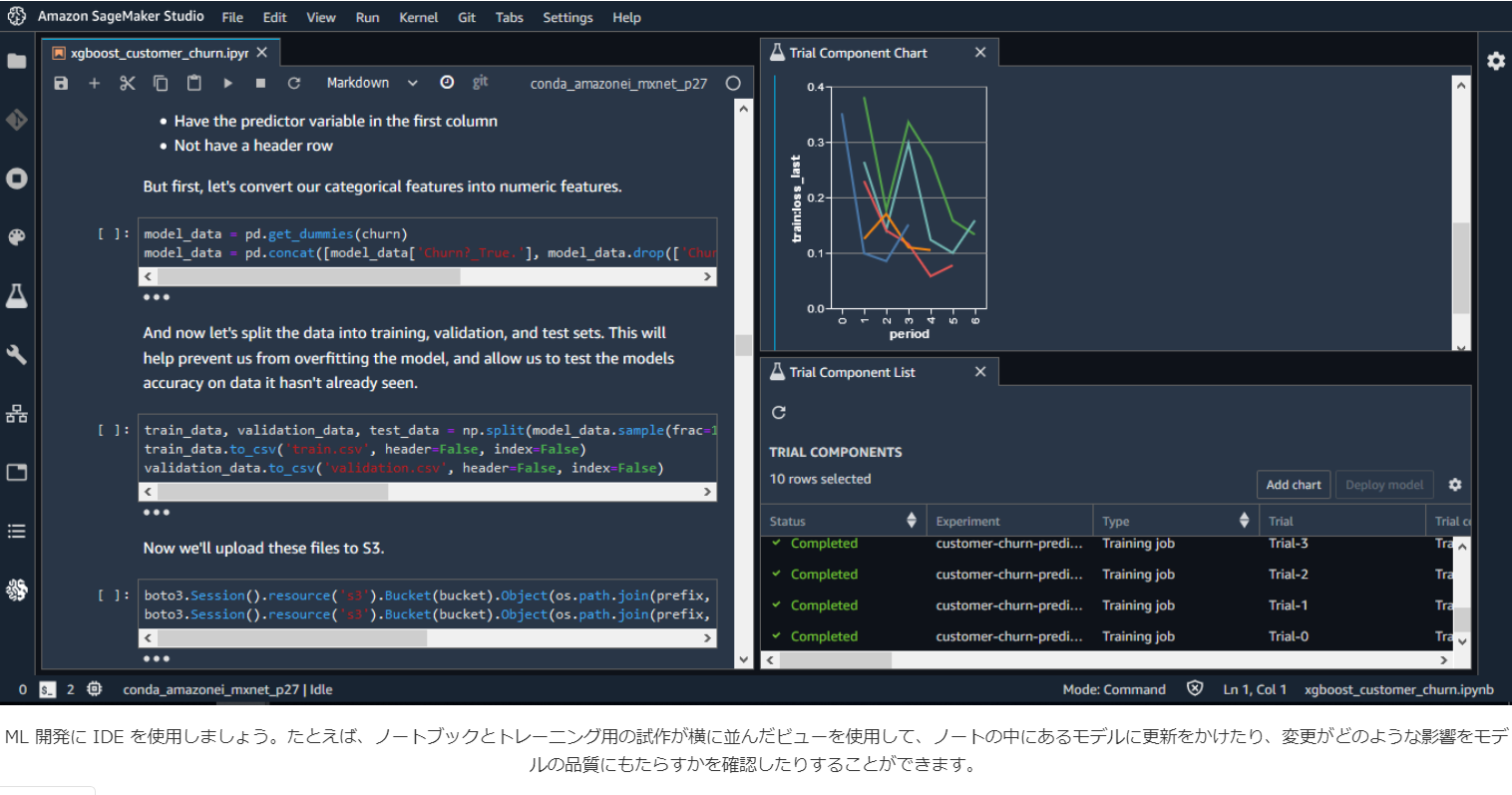

特に機械学習のサービスは豊富なリリースが発表され、大注目されています。今回は初心者の方向けに分かりやすく「Amazon SageMaker Studio」というAWSの機械学習における幅広いサービスを一つの画面で実行できる環境について、ご紹介させて頂きたいと思います。

AWS re:Inventって?

AWSイベント 公式ページより

AWS re:Invent は、AWSやパートナーによって多くの新サービスや新機能が発表と、 1,800 を超えるセッションや最新のテクノロジーの展示やデモンストレーションが行われます。

またテクノロジーを満喫できるパーティ re:Playなどの様々なプログラムがラスベガスのエリアで開催される、AWS最大にして世界規模のカンファレンスです。Amazon SageMaker Studio

Machine learning開発に必要なすべてのツールを統合したWebベースの統合開発環境(IDE)。

AWSが機械学習に特化した統合開発環境としては初のサービス。ぜーんぶまるっと統合した状態で視覚的にわかりやすく、機械学習に必要になるすべての環境が自動的に用意されています。

これにより迅速に変更を加え、結果を観察し、より速く反復することができるので反映する時間を短縮できます。開発の生産性を大幅に向上できそうです!Webベースで動作するので、Webブラウザから利用することができ、プロジェクトを作成する段階で自動的にインスタンスの作成やサーバのセットアップも完了しインフラの管理も必要がない仕様になっています。

統合されているツール

- Notebooks

- notebookをささっと使い始められる

- Experiments

- 機械学習の実験を構成・記録・比較できる

- Debugger

- リアルタイムに自動アラートでモデルのバグを排除する

- Model Monitor

- 稼働中のモデルの監視、検出ができる

- Autopilot

- どのような判断によってモデルを構築したかを、詳細に視覚化する。ユーザーのデータから最適なモデルを自動的に作成できます。

なぜ統合開発環境が必要か

自前で機械学習を行うすべての実行環境を行おうとすると、本来は複雑な作業をする上、ツールの行き来を手動で行うのでいちいち時間がかかるといった面倒があります。

機械学習を行う手順とそれらを実行するツール間が全て別々になっているからです。

- データの収集と前処理

- モデリング

- 学習

- 評価と最適化

- アプリケーションへの組み込み

たとえば、新しいアルゴリズム(問題を解くための計算方法や手順)を試したりハイパーパラメーター(推論や予測の枠組みの中で決定されないパラメータのこと)を設定する際、数百や数千の実験を行いますが、この実験結果をすべて手動で管理することになります。

これに時間がかかりすぎると、最善のモデルを見つけ出すことや実験の中で得た知見を活用することが非常に難しくなります。その課題を解決するためにAmazon SageMaker Studioを使用するべきということです。

活用法

- 作業工程、学習、訓練、データの展開や実行するプログラムを作るコードの記述。

- 実験を追跡、データの視覚化、バグを修正する作業と監視

- ノートブック、データセット、コード設定、 トレーニングの分析、アラートを管理

- モデルのチューニング、モニタリング

- データセットの前処理やパラメータを調節したり、 複製、再生したりできる

- 手順のすべては環境内で追跡

- 同じプロジェクトに対して作業している他のユーザーと、プロジェクトやフォルダを共有する機能もありそこでノートブックや成果について議論することができます。

12月12日(木)現時点ではオハイオUS Eastリージョンで使用可能です。

早く活用できるようになりたーい!公式サイトリンク

- 投稿日:2019-12-09T17:41:37+09:00

SREやクラウドエンジニアが読むと良さげな本まとめ

一年半ぐらい前にアプリケーションエンジニアからSREにコンバートした筆者が、いま役に立ってるなぁっていう本を紹介します。アプリケーションコードを書いてるときは下のレイヤの技術に興味なかったんですが、改めて勉強してみると楽しいです。

コンピュータシステム

クラウド全盛とはいえ、コンピュータの仕組みはおさえておくと役立ちます。コレ系の本はわりと小難しいものが多いですが、個人的に楽しく読めた本を紹介します。

Raspberry Piで学ぶコンピュータアーキテクチャ

Raspberry Piと銘打たれてますが、コンピュータアーキテクチャの歴史的な背景も踏まえて解説されています。プロセッサ・メモリ・ストレージ・ネットワーク・OS・プログラミングなど、コンピュータ単体の基本的な知識を学べます。 歴史をあわせて知ることができるため、知的好奇心がおおいに刺激され、楽しく読むことができます。この本が難しく感じられる場合は、プログラムはなぜ動くのかもオススメです。

Linux

コマンドの使い方は入門書片手に実践すると早いですが、仕組みを知るにはやはり本がてっとり早いです。

[試して理解]Linuxのしくみ

Linuxカーネルの全体像を知るのに最適な本です。プロセススケジューラ・メモリ管理・記憶階層・ファイルシステムなど、Linuxがどのように動いているか解説しています。図解が豊富で非常に分かりやすいです。Linuxに限らずOS周りは小難しい本や分厚い本が多いですが、この本は浅すぎず深すぎずという絶妙な塩梅になっています。もっと早く出会いたかった!

詳解 Linuxカーネル

少し古いですが、日本語でLinuxカーネルについて詳述した貴重な書籍です。いきなり通読するのはちょっとキツいので、最初は興味のあるところだけつまみ食いでもよいでしょう。筆者の場合はプロセスやシグナルについて詳しく知りたかったので、その部分だけ読みました。そのうち通読チャレンジしたいところです。なお本棚に飾ってあるとカッコいい書籍のひとつだと、勝手に思っています。

ネットワーク

ネットワークは分かりやすい入門書がいくつも出版されています。

マスタリングTCP/IP―入門編―

TCP/IPについて入門するならこの本、という定番書です。それほど詳細に深入りしているわけではありませんが、とっかかりとしては十分な情報が提供されています。ネットワーク周りのプロトコルは最終的にRFCを読むことになりますが、いきなりRFCを読むのはキツいので、まずはこの本で概要をつかむのがオススメです。つい最近、第6版が出版されました。

DNSがよくわかる教科書

なんとなくとっつきずらいDNSについて学び直そうと手にとった本です。非常にわかりやすく書かれており、スラスラと読みすすめることができます。DNSの動作原理を知れるのもよいのですが、個人的にはサイバー攻撃とその対策がとても面白かったです。DNSってキーワードは知ってるけど、実はよくわかってないんだよな〜という人にオススメです。

インフラ基礎

一言でインフラと言っても幅広いですが、特にクラウドメインのエンジニアに役立ちそうな本を集めました。

インフラエンジニアの教科書2

インフラの基本が幅広く網羅されており、OS・ネットワーク・データベース・セキュリティ・障害対応の基本を学べます。この本では運用時に起こりやすい問題もまとめられており、実践的なノウハウが満載です。インフラの本としては珍しく薄いので、挫折しづらいのもポイントが高いです。アプリケーションエンジニアにも読んでほしいオススメの一冊です。クラウドではなく自身でハードウェアの選定を行う人はインフラエンジニアの教科書もあわせてどうぞ。

絵で見てわかるITインフラの仕組み

システム設計で必要になる知識が平易な言葉で解説されています。同期/非同期・キュー・排他制御・キャッシュ・レプリケーションなど、説明なしで使われることの多い用語を丁寧に説明しています。また3層アーキテクチャのWebシステムやシステムの冗長化、パフォーマンスチューニングの基礎などを図解もふんだんに交えて解説します。システム設計においては基本的なことばかりですが、意外とこのレベルのことを分かりやすく解説した本は少ないので貴重です。書籍ではないですがGitHubで公開されているシステム設計入門もあわせてどうぞ。

Infrastructure as Code