- 投稿日:2021-02-20T23:50:59+09:00

MacのPython開発環境作成メモ

はじめに

Python環境作成時の自分用メモです。下記を参考にしました。

Macにpyenv + AnacondaでPython環境作成の備忘録

【初心者向け】Anacondaで仮想環境を作ってみる

pyenv-virtualenvを使って都合のいいように Pythonパッケージ環境を行き来する話

Macに0からpyenv + pyenv-virtualenvでpython環境を作る動作環境

macOS Catalina 10.15.7

1. pyenv, pyenv-virtualenvのinstall

pyenvとpyenv-virtualenvはすでに入っていたので、実際にはinstall作業していないけれど、必要な作業は下記。

zsh$ brew install pyenv pyenv-virtualenvpyenvにPathを通す。.zshrcに以下を追加して

source .bash_profileで設定を適用する。vimexport PATH="$HOME/.pyenv/bin:$PATH" eval "$(pyenv init -)" eval "$(pyenv virtualenv-init -)"2. Anacondaのinstall

pyenvでAnacondaをinstallする。

zsh#install可能なpythonは下記で検索可能。Anacondaだけではなくいろいろ。 $ pyenv install --list #anaconda3-5.1.0をinstall $ pyenv install anaconda3-5.1.0 #installされたpythonのversionを確認 $ pyenv versions * system (set by /Users/user/.pyenv/version) anaconda3-5.1.03. virtualenvを作成する

pyenv virtualenv installしたpython 環境名で環境を作成する。zsh$ pyenv virtualenv anaconda3-5.1.0 anaconda3-510env #installされるパッケージの名前とかいろいろ出てくるworkディレクトリにvirtualenvをあてる。

zsh$ pyenv versions system * anaconda3-5.1.0 (set by /Users/user/.pyenv/version) #Anacondaをglobalに切り替え $ pyenv global anaconda3-5.1.0 #workディレクトリを作成する。プロンプトの前に現在のpythonの環境が出てくる。便利 (anaconda3-5.1.0) $ mkdir anaconda3-510env (anaconda3-5.1.0) $ cd anaconda3-510env #workディレクトリにanaconda環境をあてる。workディレクトリに移動するとanacondaが使えるようになる (anaconda3-5.1.0) $ pyenv local anaconda3-5.1.0 (anaconda3-5.1.0) $ pyenv versions system * anaconda3-5.1.0 (set by /Users/user/anaconda3-510env/.python-version) #condaで仮想環境を作る (anaconda3-5.1.0) $ conda create --name py36 python=3.6 (anaconda3-5.1.0) $ pyenv versions system * anaconda3-5.1.0 (set by /Users/user/anaconda3-510env/.python-version) anaconda3-5.1.0/envs/py36 #py36用のworkディレクトリを作成 (anaconda3-5.1.0) $ mkdir py36 (anaconda3-5.1.0) $ cd py36 #py36workディレクトリにpy36環境をあてる (anaconda3-5.1.0) $ pyenv local anaconda3-5.1.0/envs/py36 (anaconda3-5.1.0/envs/py36) $ pyenv versions system anaconda3-5.1.0 * anaconda3-5.1.0/envs/py36 (set by /Users/user/anaconda3-510env/py36/.python-version) #ディレクトリを移動するとpython環境が変わる。すごい、便利 (anaconda3-5.1.0/envs/py36) $ cd ../ (anaconda3-5.1.0) $ pyenv versions system * anaconda3-5.1.0 (set by /Users/user/anaconda3-510env/.python-version) anaconda3-5.1.0/envs/py36 #systemをglobalに戻す(必要に応じて) (anaconda3-5.1.0) $ pyenv global system4. Jupyter Notebookの設定

condaで作成した仮想環境py36にはJupyter Notebookが入っていない。Jupyter Notebookのカーネルを設定する上で必要なので、インストールして諸々設定を行う。

zsh#py36環境にjupyterをinstall $ cd py36 $ pip install jupyter #baseに戻って、environment_kernelsをinstall $ cd ../ $ pip install environment_kernels #設定ファイル作成 $ jupyter notebook --generate-config Writing default config to: /Users/achi/.jupyter/jupyter_notebook_config.py $ echo "c.NotebookApp.kernel_spec_manager_class = 'environment_kernels.EnvironmentKernelSpecManager'" >> ~/.jupyter/jupyter_notebook_config.py $ echo "c.EnvironmentKernelSpecManager.conda_env_dirs=['/Users/user/.pyenv/versions/anaconda3-5.1.0/envs/']" >> ~/.jupyter/jupyter_notebook_config.pyJupyter Notebookを開いて、設定した環境が出てきたら設定完了。

お疲れ様でした。

- 投稿日:2021-02-20T23:11:49+09:00

spaCy + GiNZAではじめて形態素解析してみた

What is this?

- 自然言語処理の超初心者である筆者が(ほぼ)はじめて形態素解析してみました

- spaCy + GiNZAを利用して実施してみました

- 想像以上に簡単にできました!

- はじめてにしては上出来なレベル

実施環境

- Debian GNU/Linux 10

- Python: 3.9.1

- ginza:4.0.5

spaCyとは?

オージス総研によるオブジェクトの広場での解説が個人的にわかりやすかったため、引用させていただきました。

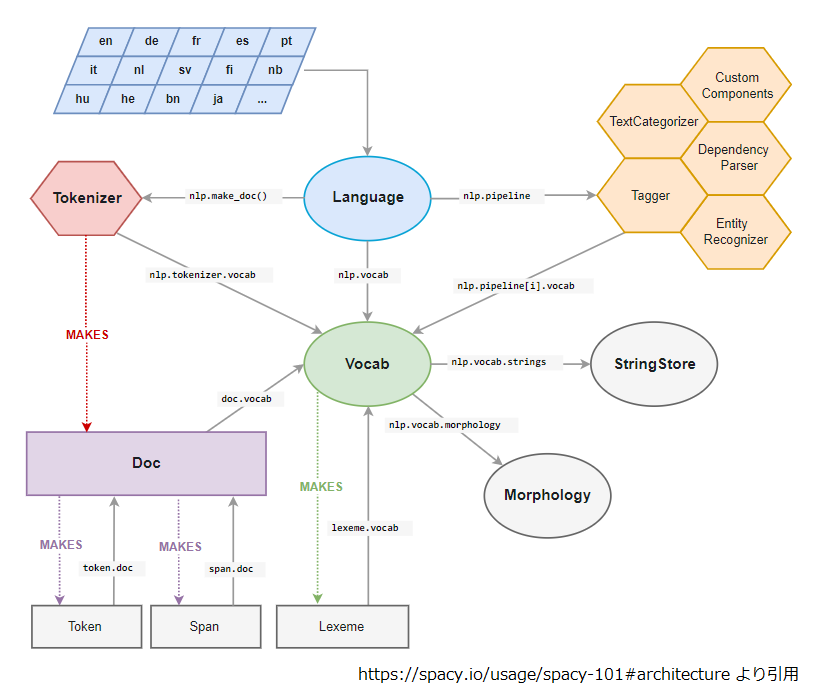

spaCy は Explosion AI 社の開発する Python/Cython で実装されたオープンソースの自然言語処理ライブラリで MIT ライセンスで利用が可能です。多くの言語をサポートし、学習済みの統計モデルと単語ベクトルが付属しています。

(https://www.ogis-ri.co.jp/otc/hiroba/technical/similar-document-search/part4.html より引用)名前の通り、Cythonで実装されているんですね。また、同記事内のspaCyの構造図に関しても、細かくは理解できていないものの、わかった気になれます。

ただし、GiNZAが登場するまでは、日本語を解析する際に工夫が必要だったようです。

しかし最近まで spaCy の学習済みモデルには日本語に対応したものがなく、バックエンドに MeCab を用いた形態素解析ができる程度でした。その為、spaCy を利用して記述された自然言語処理のアプリケーションやライブラリでは日本語の文書を処理することができない状況が続いていました。

(https://www.ogis-ri.co.jp/otc/hiroba/technical/similar-document-search/part4.html より引用)GiNZAとは?

こちらも同記事の解説がわかりやすいです。

ここで、2019年4月にリクルートと国立国語研究所の研究成果である GiNZA が登場します。主な特徴をリクルート社のリリース*1から引用すると、

1. 高度な自然言語処理をワンステップで導入完了

2. 高速・高精度な解析処理と依存構造解析レベルの国際化に対応

3. 国立国語研究所との共同研究成果の学習モデルを提供

とのことで、早い話が spaCy を日本語で利用できるようになった!pip install 一発でインストールできるので導入も簡単!!ということでよいかと思います。

(https://www.ogis-ri.co.jp/otc/hiroba/technical/similar-document-search/part4.htmlより引用)なお、scaPyとGiNZAの関係性としては、GiNZAは上記scaPyの構造における図内では"Language"にあたる機能を提供しているようです。

余談ですが、spaCyを始めようと思って調べ始めたら、GiNZAというのが出てきたので、思考停止でそのままGoogle検索したら「銀座 日本 東京の地名」が検索結果で表示されました。そりゃそうですよね。実行環境のセットアップ

なにかと環境構築に躓きやすいイメージのある自然言語ですが、私の環境ではpipにて簡単に構築することができました!

pip install -U ginza*実際にはDocker環境にてrequirements.txtに

spacyとginzaを記載してインストールを行いましたが、問題なく動作しました。使い方

こちらを参考に実行しました。

https://note.com/npaka/n/n5c3e4ca67956import spacy import ginza import pandas as pd nlp = spacy.load('ja_ginza') # spacyにginzaを使用することを指定 txt = '私は機械学習を勉強しています。' # 入力文字列 doc = nlp(txt) # モデルへ適応 ginza.set_split_mode(nlp, "C") # 形態素の分割モード指定 # 結果をデータフレームに格納 result_list = [] for sent in doc.sents: result_list = result_list + [[str(token.i), token.text, token.lemma_, token.pos_, token.tag_] for token in sent] df_result = pd.DataFrame(result_list, columns = ['token_no', 'text', 'lemma', 'pos', 'tag'])

doc.sentsにて各文のイテレータを取得します(今回の例は1文なので、要素は1つです。)。また、sent自身をさらにループに回すことで各単語での要素を取得できます。結果

今回はデータフレームに結果を格納したため、このようなテーブルが出力されます。

token_no text lemma pos tag 0 私 私 PRON 代名詞 1 は は ADP 助詞-係助詞 2 機械学習 機械学習 NOUN 名詞-普通名詞-一般 3 を を ADP 助詞-格助詞 4 勉強 勉強 VERB 名詞-普通名詞-サ変可能 5 し する AUX 動詞-非自立可能 6 て て SCONJ 助詞-接続助詞 7 い いる AUX 動詞-非自立可能 8 ます ます AUX 助動詞 9 。 。 PUNCT 補助記号-句点 特に違和感なく、形態素解析ができているかと思います。自然言語処理の素人として感じたことは、「勉強する」の「勉強」という部分が名詞タグだけれども、文の中では動詞として認識されていることが、すごいなと感じました。

参考文献

- 投稿日:2021-02-20T23:05:38+09:00

Pythonで数式を書く_02(tanh)

数式

以下がtanh関数(hyperbolic tangent function)です。

※tanhはハイパボリックタンジェントやタンエイチと読みます。日本語では双曲線正接関数と呼びます。y\ = \frac{e^{x}-e^{-x}}{e^{x}+e^{-x}}Pythonで記述

import numpy as np # tanh関数 y = (np.exp(x) - np.exp(-x)) / (np.exp(x) + np.exp(-x))上の記述方法の他に次のような方法もあります。

import numpy as np # tanh関数 y = np.tanh(x)一番最初の記載方法だと長いので、

以降は np.tanh(x) の方で記載していきます。import numpy as np x = -1 y = np.tanh(x) print(y)x=-1の出力結果-0.7615941559557649コードを省略しますが、x = 0 と x = 1 のときは以下のように出力されます。

x=0の出力結果0.0x=1の出力結果0.7615941559557649tanh関数を視覚化

先ほどの入力と出力を表にまとめると次のようになります。

x = -1 x = 0 x = 1 出力結果 y -0.76 0.0 0.76 表だけだとわかりにくいですが、

グラフにするとtanhの出力は -1 ~ 1 の間になることがわかります。

ちなみに、上のグラフは以下のコードで描くことができます。

import matplotlib.pyplot as plt import numpy as np x = np.arange(-5, 5, 0.1) y = np.tanh(x) plt.plot(x, y) plt.title("tanh") plt.xlabel("x") plt.ylabel("y") plt.show()シグモイド関数と同様にtanhもニューラルネットワークの活性化関数として利用されますので、

その方面に興味のある方はこちらも覚えておいてもよいかもしれません。

- 投稿日:2021-02-20T23:03:52+09:00

SOMPO HD プログラミングコンテスト2021(AtCoder Beginner Contest 192) 参戦記

SOMPO HD プログラミングコンテスト2021(AtCoder Beginner Contest 192) 参戦記

ABC192A - Star

1分で突破. 書くだけ.

X = int(input()) print(100 - X % 100)ABC192B - uNrEaDaBlE sTrInG

3分で突破. 書くだけだけど、0-indexed と 1-indexed で偶奇が入れ替わるのを間違えて無駄に時間を取った.

S = input() for i in range(0, len(S), 2): if S[i] != S[i].lower(): print('No') exit() for i in range(1, len(S), 2): if S[i] != S[i].upper(): print('No') exit() print('Yes')ABC192C - Kaprekar Number

6分で突破. 書くだけだったけど、計算量が計算できなくて、大丈夫かなってなった.

def g1(x): return int(''.join(sorted(str(x), reverse=True))) def g2(x): return int(''.join(sorted(str(x)))) def f(x): return g1(x) - g2(x) N, K = map(int, input().split()) a = N for i in range(K): a = f(a) print(a)ABC192E - Train

24分で突破. WA1. 最初、特定の都市間には一つしか路線がないように書いて WA した、まぬけ. まあ、ダイクストラすればいいだけですね.

from sys import stdin from heapq import heappop, heappush readline = stdin.readline INF = 10 ** 18 N, M, X, Y = map(int, readline().split()) links = [{} for _ in range(N)] for _ in range(M): A, B, T, K = map(int, readline().split()) links[A - 1].setdefault(B - 1, []) links[B - 1].setdefault(A - 1, []) links[A - 1][B - 1].append((T, K)) links[B - 1][A - 1].append((T, K)) dp = [INF] * N dp[X - 1] = 0 q = [(0, X - 1)] while len(q) != 0: n, i = heappop(q) link = links[i] for j in link: for t, k in link[j]: d = (n + k - 1) // k * k if d + t >= dp[j]: continue dp[j] = d + t heappush(q, (d + t, j)) if dp[Y - 1] == INF: print(-1) else: print(dp[Y - 1])ABC192D - Base n

48分半で突破. WA5. Xが1桁のときの特別性に気づくのに時間がかかったし、気づいた後も求められているのがn進法表記の数とみなして得られる値の種類数であることになかなか気づかなかった. やらかしたなあ.

def f(s, n): result = 0 b = 1 for c in s[::-1]: result += int(c) * b b *= n return result INF = 10 ** 19 X = input() M = int(input()) d = int(max(X)) ok = d ng = INF + 1 while ng - ok > 1: m = ok + (ng - ok) // 2 if f(X, m) <= M: ok = m else: ng = m if ok == INF: print(1) else: print(ok - d)

- 投稿日:2021-02-20T22:54:55+09:00

Pythonで学ぶ制御工学 第4弾:状態空間モデル

#Pythonで学ぶ制御工学< 状態空間モデル >

はじめに

基本的な制御工学をPythonで実装し,復習も兼ねて制御工学への理解をより深めることが目的である.

その第4弾として状態空間モデルを扱う.状態空間モデル

行列表現とすることで,多元高階の微分方程式を1階の微分方程式で表現するもの

伝達関数との違いや,状態空間モデルの一般式を次の図で示す.

状態空間モデルの計算

以下では,前々回から扱っている制御モデルについて状態空間モデルをそれぞれ求める過程を示す.なお,ここで扱う制御モデルは1入力1出力である.

状態空間モデル①:台車

状態空間モデル②:アーム

状態空間モデル③:RLC回路

状態空間モデル④:増幅回路

実装

ここでは,Python上で状態空間モデルを表現する方法を学ぶために実装する.そのため,適当な値を用いて実装している.以下にソースコードとそのときの出力を示す.

ソースコード

state_space_model.py""" 2021/02/20 @Yuya Shimizu 状態空間モデル """ from control import ss, ssdata ##ss関数では,MATLAB表記が可能 #状態空間モデル構築 A = '0 1; -1 -1' B = '0 ; 1' C = '1 0' D = '0' state_model = ss(A, B, C, D) print(f"<状態空間モデル>\n{state_model}\n") #状態空間モデルからA~D行列の抽出 print("<定数行列A~D>") print('A=', state_model.A) print('B=', state_model.B) print('C=', state_model.C) print('D=', state_model.D) #もしくは,以下の方法でまとめて抽出できる sysA, sysB, sysC, sysD = ssdata(state_model)出力

<状態空間モデル> A = [[ 0. 1.] [-1. -1.]] B = [[0.] [1.]] C = [[1. 0.]] D = [[0.]] <定数行列A~D> A= [[ 0. 1.] [-1. -1.]] B= [[0.] [1.]] C= [[1. 0.]] D= [[0.]]感想

状態空間モデルの構成を復習することができた.ここでは,状態空間モデルをPython上で表現する方法についても学ぶことができた.これにより,状態空間モデルを扱うことが可能となった.ただ,状態空間モデルの定数行列はあらかじめ計算しておく必要がありそうだ.ここは,伝達関数のときと同じである.だから,また同じように物理量などを引数にするなどしてある制御モデル特有の状態空間モデル生成関数も作成できそうである.

参考文献

Pyhtonによる制御工学入門 南 祐樹 著 オーム社

- 投稿日:2021-02-20T22:47:31+09:00

scikit-learnを使ってみる(2)

前の記事「scikit-learnを使ってみる」で三角関数の学習がうまくできなかった。トレーニングデータではそこそこ学習できても、テストデータの結果はボロボロだった。

今回は方法を変更して、sin関数で作成した連続した3つの値から次の値を学習させていく。下図で説明すると、緑の点3つから赤の点を学習させることになる。これを順次行う。

三角関数(2)

import numpy as np from sklearn.model_selection import train_test_split from sklearn.linear_model import LinearRegression import matplotlib.pyplot as plt look_back = 3 def make_data(y, look_back): X = [] Y = [] for i in np.arange(len(y) - look_back): X.append(y[i:i+look_back]) Y.append(y[i+look_back]) return X, Y # 三角関数 Y = sin(X)を求める。 x = np.linspace(0, 20, num=200) y = np.sin(x) X, Y = make_data(y, look_back=look_back) X_train, X_test, Y_train, Y_test = train_test_split(X, Y, shuffle=False) lr = LinearRegression() lr.fit(X_train, Y_train) print(f'回帰係数={lr.coef_}') print(f'切片={lr.intercept_}') print(f'決定係数={lr.score(X_train, Y_train)}') plt.scatter(x, y, label='data') plt.plot(x[look_back:look_back+len(X_train)], lr.predict(X_train), color='green', label='train') plt.plot(x[look_back+len(X_train):], lr.predict(X_test), color='red', label='test') plt.legend() plt.savefig('linear_regression6.png') plt.show()さて結果は...

うまく学習できたようだ。

- 投稿日:2021-02-20T22:35:21+09:00

[PyTorch]Upsampleクラスのalign_cornersの動作

はじめに

画像セグメンテーションや敵対的生成ネットワーク等で利用されるPyTorch Upsampleクラスのalign_cornersの動作が気になったので、メモを残します。

環境

- Windows 10 home

- Python(3.7.6)

- Numpy(1.19.4)

Upsampleクラスのalign_corners

PyTorch Upsampleクラスは、scale_factorサイズにより、画像データであれば、縦横を拡大するものです。拡大のためには、増加する点を補間する必要があります。補間方法には、大きく分けると、近傍の値と同一ものをとるか(nearest)、線形補間するか(linear, bilinearなど)があります。

今回は、線形補間系に機能する、align_cornersの話です。align_cornersは、公式ドキュメントでは、以下のように説明しています。align_corners (bool, optional) – if

True, the corner pixels of the input and output tensors are aligned, and thus preserving the values at those pixels.exampleでは、

>>> input = torch.arange(1, 5, dtype=torch.float32).view(1, 1, 2, 2) >>> input tensor([[[[ 1., 2.], [ 3., 4.]]]]) >>> m = nn.Upsample(scale_factor=2, mode='bilinear') # align_corners=False >>> m(input) tensor([[[[ 1.0000, 1.2500, 1.7500, 2.0000], [ 1.5000, 1.7500, 2.2500, 2.5000], [ 2.5000, 2.7500, 3.2500, 3.5000], [ 3.0000, 3.2500, 3.7500, 4.0000]]]]) >>> m = nn.Upsample(scale_factor=2, mode='bilinear', align_corners=True) >>> m(input) tensor([[[[ 1.0000, 1.3333, 1.6667, 2.0000], [ 1.6667, 2.0000, 2.3333, 2.6667], [ 2.3333, 2.6667, 3.0000, 3.3333], [ 3.0000, 3.3333, 3.6667, 4.0000]]]])と書かれています。cornerの値は、align_corners=Trueとalign_corners=Falseに違いがないような気がして、何がalignされているのか、私はよくわかりませんでした。

調べてみると、PyTorchのdiscussionに、以下の説明がありました。When

align_corners=True, pixels are regarded as a grid of points. Points at the corners are aligned.When

align_corners=False, pixels are regarded as 1x1 areas. Area boundaries, rather than their centers, are aligned.どうも元となる配列の値を、拡大した配列のどこに配置し補間するかが違いのようです。では、この図をもとに、Numpyを使って検証してみます。

検証

Numpyに直接bilinearを扱う関数がなかったので、PyTorch Upsample クラスのexamplesの左端の列を対象に、線形補間をする関数のnumpy.interpで、Upsampleの結果を再現します(下図)。

図1:PyTorch Upsample examplesで検証に利用する列。Upsamleクラスexamplesより抜粋。align_corners=Trueの場合

align_cornersをTrueにすると、拡大配列の端の点と、元配列の端の点を合わせて、拡大配列の値を内挿します。

図2:align_corners=Trueの時の動作イメージnumpy.interpを用いて、拡大配列を計算します。

import numpy as np before = np.array([1, 3]) after = np.interp([0, 1, 2, 3], [0, 3], [before[0], before[1]]) print(after.reshape(4, 1))#見た目を合わせるためにreshape

図3:numpy.interpでの計算結果。左:numpy.interp、右:PyTorch Upsample align_corners=True。PyTorch Upsamle align_corners=Trueのexamplesと同じになりました。

align_corners=Falseの場合

align_cornersをFalseにすると、元配列の値を、拡大した配列の節に配置し、拡大配列の値を線形補間することになります。

図4: align_corners=Falseの時の動作イメージnumpy.interpを用いて、拡大配列を計算します。align_corners=Trueでは、拡大配列での元配列の値の位置を[0, 3]しましたが、align_corners=Falseでは、[0.5, 2.5]となっています。

import numpy as np before = np.array([1, 3]) after = np.interp([0, 1, 2, 3], [0.5, 2.5], [before[0], before[1]]) print(after.reshape(4, 1)) # 見た目を合わせるためにreshape

図5:numpy.interpでの計算結果。左:numpy.interp、右:PyTorch Upsample align_corners=False。これも、PyTorch Upsample align_corners=False examplesと同じになりました。

なお、numpy.interpは、与えられた点の外では、境界の値を出力するようです。align_corners=Falseの例だと、与えられた点の外は、after[0]やafter[-1]に当たり、それぞれafter[0] = before[0](= 1.0)とafter[-1] = before[-1](=3.0)となります。計算結果が同じなので、PyTorch Upsampleも類似の操作をしているのでしょう。

最後に、numpy.interp を組み合わせたbilinearで、PyTorch Upsampleのexamplesの2x2→4x4拡大の再現をしてみます。Numpy interpを使ってPyToch Upsample examplesを再現

align_corners=True

# align_corners=True import numpy as np column0 = np.interp([0, 1, 2, 3], [0, 3], [1, 3]) column3 = np.interp([0, 1, 2, 3], [0, 3], [2, 4]) row0 = np.interp([0,1,2,3], [0,3], [1,2]) row3 = np.interp([0,1,2,3], [0,3], [3,4]) row1 = np.interp([0,1,2,3], [0,3], [column0[1], column3[1]]) row2 = np.interp([0,1,2,3], [0,3], [column0[2], column3[2]]) align_corners_true = np.vstack([row0, row1, row2, row3]) print(align_corners_true)

図6:numpy.interpでのPyTorch Upsample align_corners=True examplesの拡大の再現。上段:numpy.interp、下段:PyTorch Upsample。align_corner=False

# align_corners=False import numpy as np column0 = np.interp([0,1,2,3], [0.5, 2.5], [1,3]) column3 = np.interp([0,1,2,3], [0.5, 2.5], [2,4]) row0 = np.interp([0,1,2,3], [0.5, 2.5], [1,2]) row3 = np.interp([0,1,2,3], [0.5, 2.5], [3,4]) row1 = np.interp([0,1,2,3], [0.5, 2.5], [column0[1], column3[1]]) row2 = np.interp([0,1,2,3], [0.5, 2.5], [column0[2], column3[2]]) align_corners_false = np.vstack([row0, row1, row2, row3]) print(align_corners_false)

図7: numpy.interpでのPyTorch Upsample align_corners=False examplesの拡大の再現。上段:numpy.interp、下段:PyTorch Upsample。numpy.interpでPyTorchのdiscussion説明内容の操作を行って、PyTorch Upsampleクラスexamplesと同じ結果となることが確認できました。

参考

https://discuss.pytorch.org/t/what-we-should-use-align-corners-false/22663/6

- 投稿日:2021-02-20T22:17:10+09:00

webdriver_manager マジ便利

何が便利なの?

仕事してると定期的に、これブラウザ操作で勝手にやってくれんかな・・って時あるよね

自分は本当に楽をしたい気持ちがいっぱいなので、定期的にこれ思います。

そんな時に使うのがseleniumさん。

ただ、ブラウザ操作するためにwebドライバー必要だよね。

しかもバージョンをしっかり合わせたやつ・・・。使おう!って思った時に、あ・・なんか動かないわ・・手動でやるか・・ってことが多かったんですが、webdriver_managerを入れてからそんなことがなくなりました

webdriver_managerとは?

ファイル実行時に、適合するwebドライバーを勝手にダウンロードしてきてくれるやつ!

実行時に何やらキャッシュがどうこうっていうのが出てくるから、一回使ったドライバーはキャッシュとして保存しておいてくれてるっぽい(調べてはないけど)インストール方法は?

pip install webdriver-managerさいごに

ちょっとだけセレニウム使おうとして、ドライバーがあってなくて動かない時、もうほんとにストレスですよね。

ダウンロードするほどじゃないんよ・・・みたいな。これ入れとくことで、気軽にセレニウム使えてます

- 投稿日:2021-02-20T21:49:55+09:00

データテーブルの横方向への連結 2(内部結合)

テーブルとテーブルの連結には、縦方向(行が増える)と横方向(列が増える)の場合があります。

縦方向の場合は集合、横方向の場合は結合と言います。結合には以下のパターンがあります。

完全外部結合:共通しないレコードをすべて含めて列を増やす。

右(左)外部結合:右(左)側のテーブルの共通しないレコードを含めて列を増やす。

内部結合:共通するレコードを対象として列を増やす。

今回は、内部結合について、SAS プログラムと SQL、および Python (Pandas) をそれぞれ用いた例を紹介します。行いたい操作は下記です。

A列をキーとして、値が一致するレコードのみを取り出して、横方向に連結します。① SAS プログラムでの内部結合

data table_3; merge table_1 (in=flg1) table_2 (in=flg2); by A; if flg1=1 and flg2=1 then output; run;merge ステートメントで横に重ねて、 by でキーとなる変数を指定します。

in は、一時変数を指定するオプションです。

具体的には例えば、table_1 ( in =flg1) では、一時変数名をflg1として設定しており、

・table_1 由来のレコードでは flg1=1

・それ以外では flg1=0

となります。

さらに一時変数として指定した flg1 と flg2 は、出力テーブルには出力されません。例えば、下記プログラムでは、

data table_4; merge table_1 (in=flg1) table_2 (in=flg2); by A; val1=flg1; val2=flg2; run;出力は下記となります。一時変数の値を強制的に表示させるため、val1, val2 でそれぞれ値を引き継がせています。

val1 が table_1 起因、val2 が table_2 起因であることがわかると思います。

改めて下記プログラムに戻ると、

data table_3; merge table_1 (in=flg1) table_2 (in=flg2); by A; if flg1=1 and flg2=1 then output; run;if flg1=1 and flg2=1 then output; で、flg1 (=val1) と flg2 (=val2) が共に 1 であるレコードを出力 (then output) させることで、内部結合に相当するテーブルが得られます。

② SQL での内部結合

create table table_3 as select table_1.A, B, C from table_1 inner join table_2 on table_1.A = table_2.A;SELECT 取り出す変数名 from データセット1 inner join データセット2 on 結合条件

(inner は省略してもOK)

結合したいテーブルどうしを inner join でつなぎ、on 以下でどの列を基準にデータを一致させるかを指定します。

また、inner join ~ on を使わずに、where句を使って次のように記述することもできます。create table table_3 as select table_1.A, B, C from table_1, table_2 where table_1.A = table_2.A;③ Python (Pandas) での完全外部結合

import pandas as pd table_1 = pd.DataFrame({'A': [1, 2], 'B': ['AA', 'BB']}) table_2 = pd.DataFrame({'A': [2, 3], 'C': [10, 20]}) table_3 = pd.merge(table_1, table_2, on = "A", how="inner").merge で結合、on にキー列を指定、how で様式(内部なので "inner")を指定します。

出力結果

ちなみに how の様式指定では、 "outer" が完全外部結合、"left" ("right") が左 (右) 外部結合となります。関連記事

- 投稿日:2021-02-20T21:49:55+09:00

データテーブルの連結ー横方向2(内部結合)

テーブルとテーブルの連結には、縦方向(行が増える)と横方向(列が増える)の場合があります。

縦方向の場合は集合、横方向の場合は結合と言います。結合には以下のパターンがあります。

完全外部結合:共通しないレコードをすべて含めて列を増やす。

右(左)外部結合:右(左)側のテーブルの共通しないレコードを含めて列を増やす。

内部結合:共通するレコードを対象として列を増やす。

今回は、内部結合について、SAS プログラムと SQL、および Python (Pandas) をそれぞれ用いた例を紹介します。行いたい操作は下記です。

A列をキーとして、値が一致するレコードのみを取り出して、横方向に連結します。① SAS プログラムでの内部結合

data table_3; merge table_1 (in=flg1) table_2 (in=flg2); by A; if flg1=1 and flg2=1 then output; run;merge ステートメントで横に重ねて、 by でキーとなる変数を指定します。

in は、一時変数を指定するオプションです。

具体的には例えば、table_1 ( in =flg1) では、一時変数名をflg1として設定しており、

・table_1 由来のレコードでは flg1=1

・それ以外では flg1=0

となります。

さらに一時変数として指定した flg1 と flg2 は、出力テーブルには出力されません。例えば、下記プログラムでは、

data table_4; merge table_1 (in=flg1) table_2 (in=flg2); by A; val1=flg1; val2=flg2; run;出力は下記となります。一時変数の値を強制的に表示させるため、val1, val2 でそれぞれ値を引き継がせています。

val1 が table_1 起因、val2 が table_2 起因であることがわかると思います。

改めて下記プログラムに戻ると、

data table_3; merge table_1 (in=flg1) table_2 (in=flg2); by A; if flg1=1 and flg2=1 then output; run;if flg1=1 and flg2=1 then output; で、flg1 (=val1) と flg2 (=val2) が共に 1 であるレコードを出力 (then output) させることで、内部結合に相当するテーブルが得られます。

② SQL での内部結合

create table table_3 as select table_1.A, B, C from table_1 inner join table_2 on table_1.A = table_2.A;SELECT 取り出す変数名 from データセット1 inner join データセット2 on 結合条件

(inner は省略してもOK)

結合したいテーブルどうしを inner join でつなぎ、on 以下でどの列を基準にデータを一致させるかを指定します。

また、inner join ~ on を使わずに、where句を使って次のように記述することもできます。create table table_3 as select table_1.A, B, C from table_1, table_2 where table_1.A = table_2.A;③ Python (Pandas) での完全外部結合

import pandas as pd table_1 = pd.DataFrame({'A': [1, 2], 'B': ['AA', 'BB']}) table_2 = pd.DataFrame({'A': [2, 3], 'C': [10, 20]}) table_3 = pd.merge(table_1, table_2, on = "A", how="inner").merge で結合、on にキー列を指定、how で様式(内部なので "inner")を指定します。

出力結果

ちなみに how の様式指定では、 "outer" が完全外部結合、"left" ("right") が左 (右) 外部結合となります。関連記事(本記事含む)

データテーブルの連結-縦方向 1(異なる列名をそのまま残す場合)

データテーブルの連結-縦方向 2(異なる列名を統合する場合)

データテーブルの連結-縦方向 3(積集合と差集合)

データテーブルの連結-横方向 1(完全外部結合)

データテーブルの連結-横方向 2(内部結合)

- 投稿日:2021-02-20T21:45:22+09:00

転移学習・ファインチューニング【実装】

はじめに

今回は、学習済モデルを使った「転移学習及びファインチューニング」の実装をしていきます!!

ディープラーニングや畳み込みニューラルネットワークの基本については、下記の記事を参照してください。

?基本となるディープラーニング

https://qiita.com/hara_tatsu/items/c0e59b388823769f9704?ディープラーニングの実装及び過学習対策

https://qiita.com/hara_tatsu/items/b7423e90574cf7730978?「畳み込みニューラルネットワーク(CNN)まとめ」

https://qiita.com/hara_tatsu/items/8dcd0a339ad2f67932e7?畳み込みニューラルネットワーク(CNN)の実装

https://qiita.com/hara_tatsu/items/d2c6536ae35cca5e97ab学習済モデルを使う理由

ディープラーニングで新しいモデルを作成するときの最大の悩みは、学習用データのデータ量。

少ないデータ量だと、限られた学習用データからの特徴抽出しかできない。そのため精度が悪く、過学習も起こりやすい。そんなときに使われる手法が「転移学習又はファインチューニング」。

大量のデータセットで学習されている学習済モデルの特徴抽出を利用することで、少ないデータ量でも精度の良いモデルを作成することができる。

転移学習とは

学習済モデルを特徴抽出器として利用する方法。

学習済モデル(特徴抽出) → 追加する層(畳み込み層・全結合層) → 出力層

学習済モデルから特徴を抽出した後に学習させる。

転移学習【実装】

今回は題材として、「【SIGNATE】画像ラベリング(10種類)」を使います。

https://signate.jp/competitions/133画像データに映っているものを10種類のラベルから分類するものです。

データの前処理

必要なライブラリーをインポート

python.pyimport numpy as np import pandas as pd from PIL import Image import glob目的変数と説明変数の処理

目的変数を読み込んでカテゴリー変数へ変換

python.pytrain_Y = pd.read_csv('train_master.tsv', delimiter='\t') train_Y = train_Y.drop('file_name', axis=1) # カテゴリー変数へ変換 from tensorflow.keras.utils import to_categorical Y = to_categorical(train_Y) print(Y.shape) print(Y[:5]) (5000, 10) array([[0., 1., 0., 0., 0., 0., 0., 0., 0., 0.], [0., 0., 0., 0., 0., 1., 0., 0., 0., 0.], [0., 1., 0., 0., 0., 0., 0., 0., 0., 0.], [0., 0., 0., 0., 0., 0., 1., 0., 0., 0.], [0., 0., 0., 1., 0., 0., 0., 0., 0., 0.]], dtype=float32)説明変数(画像データ)は、「glob」を使って読み込めるが画像データの並びがバラバラに読み込まれてしまう。そのため、読み込み後に小さい数字の順番に並び替える。

python.pytrain_file = glob.glob('train_images/t*') # 0埋めでない数値を小さい順に並び替える関数 import re from collections import OrderedDict def sortedStringList(array=[]): sortDict=OrderedDict() for splitList in array: sortDict.update({splitList:[int(x) for x in re.split("(\d+)",splitList)if bool(re.match("\d*",x).group())]}) return [sortObjKey for sortObjKey,sortObjValue in sorted(sortDict.items(), key=lambda x:x[1])] # 小さい順に並び替え sort_file = sortedStringList(train_file) print(sort_file[:5]) ['train_images/train_0.jpg', 'train_images/train_1.jpg', 'train_images/train_2.jpg', 'train_images/train_3.jpg', 'train_images/train_4.jpg']説明変数(画像データ)の前処理

現在は、「glob」で画像データのファイル名を取得している状態。

PIL形式で読み込み後にnumpy化する。※※CPU環境では学習に時間がかかる場合があるため、「image = load_img(image, target_size = (32, 32)) 」とすれば画像サイズを小さくできるので計算時間が減る。(予測精度は悪くなる可能性あり)

python.pyfrom tensorflow.keras.preprocessing.image import load_img, img_to_array, array_to_img X = [] for image in sort_file: # 画像ファイルのPIL形式で読み込み image = load_img(image) #image = load_img(image, target_size = (32, 32)) 学習時間を短縮したい場合 # PIL形式からnumpy形式へ image = img_to_array(image) # データをリストへ格納 X.append(image) #Xはリスト型のためnumpy型へ変換 X_np = np.array(X) print(X_np.shape) (5000, 96, 96, 3)学習用データ、検証用データ、テストデータへ分割

python.py# データの分割 from sklearn.model_selection import train_test_split X_train, X_test, Y_train, Y_test = train_test_split(X_np, Y, test_size=0.2, random_state=0) X_train, X_valid, Y_train, Y_valid = train_test_split(X_train, Y_train, test_size=0.2, random_state=0) # 形状を確認 print("Y_train=", Y_train.shape, ", X_train=", X_train.shape) print("Y_valid=", Y_valid.shape, ", X_valid=", X_valid.shape) print("Y_test=", Y_test.shape, ", X_test=", X_test.shape) Y_train= (3200, 10) , X_train= (3200, 96, 96, 3) Y_valid= (800, 10) , X_valid= (800, 96, 96, 3) Y_test= (1000, 10) , X_test= (1000, 96, 96, 3)学習用データの拡張と水増し

python.pyfrom tensorflow.keras.preprocessing.image import ImageDataGenerator # 学習用データの拡張設定 image_gen = ImageDataGenerator(rotation_range=45, #45°回転 horizontal_flip = True, #左右反転 rescale=1./255 #正規化 ) # 拡張データの生成 train_data_gen = image_gen.flow(X_train, Y_train, batch_size = 32, shuffle = False) # 拡張データを表示する関数 def plotImages(images_arr): fig, axes = plt.subplots(1, 5, figsize=(20,20)) axes = axes.flatten() for img, ax in zip( images_arr, axes): ax.imshow(img) ax.axis('off') plt.tight_layout() plt.show() augmented_images = [train_data_gen[0][0][0] for i in range(5)] plotImages(augmented_images)python.py#学習用データの状態確認 #3200 / 32 print(len(train_data_gen)) 100検証用データを学習用データの状態に合わせる

python.pyvalid_gen = ImageDataGenerator(rescale=1./255 #正規化) valid_data_gen = valid_gen.flow(X_valid, Y_valid, batch_size = 32) #800 / 32 print(len(valid_data_gen)) 25転移学習の実装

畳み込みニューラルネットワークの学習済モデルとして有名な「VGG16」を利用します。

他にも「Inception」,「ResNet」などあります。

※「ResNet」でも試したが、「VGG16」の方が精度が良かった。

python.pyfrom tensorflow.keras.applications.vgg16 import VGG16 base_model = VGG16(weights = 'imagenet', #学習済みの重みを使用する include_top = False, #出力層は使わない input_shape = (96, 96, 3)) #入力する画像サイズの指定 base_model.summary()VGG16の構造は以下のとおり

(畳み込み層のブロックが5つ)Model: "vgg16" _________________________________________________________________ Layer (type) Output Shape Param # ================================================================= input_1 (InputLayer) [(None, 96, 96, 3)] 0 _________________________________________________________________ block1_conv1 (Conv2D) (None, 96, 96, 64) 1792 _________________________________________________________________ block1_conv2 (Conv2D) (None, 96, 96, 64) 36928 _________________________________________________________________ block1_pool (MaxPooling2D) (None, 48, 48, 64) 0 _________________________________________________________________ block2_conv1 (Conv2D) (None, 48, 48, 128) 73856 _________________________________________________________________ block2_conv2 (Conv2D) (None, 48, 48, 128) 147584 _________________________________________________________________ block2_pool (MaxPooling2D) (None, 24, 24, 128) 0 _________________________________________________________________ block3_conv1 (Conv2D) (None, 24, 24, 256) 295168 _________________________________________________________________ block3_conv2 (Conv2D) (None, 24, 24, 256) 590080 _________________________________________________________________ block3_conv3 (Conv2D) (None, 24, 24, 256) 590080 _________________________________________________________________ block3_pool (MaxPooling2D) (None, 12, 12, 256) 0 _________________________________________________________________ block4_conv1 (Conv2D) (None, 12, 12, 512) 1180160 _________________________________________________________________ block4_conv2 (Conv2D) (None, 12, 12, 512) 2359808 _________________________________________________________________ block4_conv3 (Conv2D) (None, 12, 12, 512) 2359808 _________________________________________________________________ block4_pool (MaxPooling2D) (None, 6, 6, 512) 0 _________________________________________________________________ block5_conv1 (Conv2D) (None, 6, 6, 512) 2359808 _________________________________________________________________ block5_conv2 (Conv2D) (None, 6, 6, 512) 2359808 _________________________________________________________________ block5_conv3 (Conv2D) (None, 6, 6, 512) 2359808 _________________________________________________________________ block5_pool (MaxPooling2D) (None, 3, 3, 512) 0 ================================================================= Total params: 14,714,688 Trainable params: 14,714,688 Non-trainable params: 0 _________________________________________________________________転移学習では学習済モデルの重みは固定したままにするので以下の処理を行う。

?重みの固定をしないと全ての重みが更新されてしまうため、学習済モデルを使うメリットがなくなってしまう。

python.py# 全ての重みを固定(freeze) for layer in base_model.layers[:19]: layer.trainable = False # 重みが固定されているかの確認 for layer in base_model.layers: print(layer, layer.trainable)全てが「Flase」となっていれば重みの固定が成功している。

<tensorflow.python.keras.engine.input_layer.InputLayer object at 0x7f5cc984ff60> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f5cc984fb38> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f5cbe758fd0> False <tensorflow.python.keras.layers.pooling.MaxPooling2D object at 0x7f5cbd716f28> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f5cbd738080> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f5cbd738e10> False <tensorflow.python.keras.layers.pooling.MaxPooling2D object at 0x7f5cbd73d4e0> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f5cbd745048> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f5cbd74b400> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f5cbd752908> False <tensorflow.python.keras.layers.pooling.MaxPooling2D object at 0x7f5cbd752ac8> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f5cbd745358> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f5cbd6d9f98> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f5cbd6dc5f8> False <tensorflow.python.keras.layers.pooling.MaxPooling2D object at 0x7f5cbd6e4e48> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f5cbd6e9b00> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f5cbd6f1a90> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f5cbd6f1198> False <tensorflow.python.keras.layers.pooling.MaxPooling2D object at 0x7f5cbd6f8940> False転移学習モデルの作成

python.pymodel = keras.Sequential() # VGG16モデル model.add(base_model) # 層を追加 model.add(Conv2D(64, kernel_size=3, padding="same", activation="relu")) model.add(MaxPooling2D()) model.add(Dropout(0.25)) model.add(Flatten()) model.add(Dense(256, activation='relu')) model.add(Dropout(0.5)) model.add(Dense(128, activation="relu")) model.add(Dense(64, activation="relu")) model.add(Dropout(0.5)) model.add(Dense(10, activation='softmax')) model.summary()転移学習モデルの構造

_________________________________________________________________ Layer (type) Output Shape Param # ================================================================= vgg16 (Functional) (None, 3, 3, 512) 14714688 _________________________________________________________________ conv2d (Conv2D) (None, 3, 3, 64) 294976 _________________________________________________________________ max_pooling2d (MaxPooling2D) (None, 1, 1, 64) 0 _________________________________________________________________ dropout (Dropout) (None, 1, 1, 64) 0 _________________________________________________________________ flatten (Flatten) (None, 64) 0 _________________________________________________________________ dense (Dense) (None, 256) 16640 _________________________________________________________________ dropout_1 (Dropout) (None, 256) 0 _________________________________________________________________ dense_1 (Dense) (None, 128) 32896 _________________________________________________________________ dropout_2 (Dropout) (None, 128) 0 _________________________________________________________________ dense_2 (Dense) (None, 64) 8256 _________________________________________________________________ dropout_3 (Dropout) (None, 64) 0 _________________________________________________________________ dense_3 (Dense) (None, 10) 650 ================================================================= Total params: 15,068,106 Trainable params: 353,418 Non-trainable params: 14,714,688 _________________________________________________________________訓練されるパラメーターの確認をします。

python.pyfor layer in model.layers: print(layer, layer.trainable ) print(len(model.trainable_weights))10個のパラメータが訓練される。

<tensorflow.python.keras.engine.functional.Functional object at 0x7f5cbd6fe978> True <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f5cc984f668> True <tensorflow.python.keras.layers.pooling.MaxPooling2D object at 0x7f5cbd6d4f98> True <tensorflow.python.keras.layers.core.Dropout object at 0x7f5cbd6d4c88> True <tensorflow.python.keras.layers.core.Flatten object at 0x7f5cbd238f98> True <tensorflow.python.keras.layers.core.Dense object at 0x7f5cbd238240> True <tensorflow.python.keras.layers.core.Dropout object at 0x7f5cbd240518> True <tensorflow.python.keras.layers.core.Dense object at 0x7f5cbd240d68> True <tensorflow.python.keras.layers.core.Dropout object at 0x7f5cbd240710> True <tensorflow.python.keras.layers.core.Dense object at 0x7f5cbd252588> True <tensorflow.python.keras.layers.core.Dropout object at 0x7f5cbd25a550> True <tensorflow.python.keras.layers.core.Dense object at 0x7f5cbd25afd0> True 10python.pymodel.compile(loss='categorical_crossentropy',optimizer= 'rmsprop', metrics=['accuracy']) %%time # 学習の実施 log = model.fit_generator(train_data_gen, #学習用データ steps_per_epoch = 100, epochs = 5000, #繰り返し計算する回数 callbacks = [keras.callbacks.EarlyStopping(monitor='val_loss',#監視する値 min_delta=0, #改善とみなされる最小の量 patience=50, #設定したエポック数改善がないと終了 verbose=1, mode='auto' #監視する値が増減どうなったら終了か自動で推定 )], validation_data = valid_data_gen, #検証用データ validation_steps = 25)結果の確認

python.pyacc = log.history['accuracy'] val_acc = log.history['val_accuracy'] loss = log.history['loss'] val_loss = log.history['val_loss'] #学習回数によって変更 epochs_range = range(55) plt.figure(figsize=(8, 8)) plt.subplot(1, 2, 1) plt.plot(epochs_range, acc, label='Training Accuracy') plt.plot(epochs_range, val_acc, label='Validation Accuracy') plt.legend(loc='lower right') plt.title('Training and Validation Accuracy') plt.subplot(1, 2, 2) plt.plot(epochs_range, loss, label='Training Loss') plt.plot(epochs_range, val_loss, label='Validation Loss') plt.legend(loc='upper right') plt.title('Training and Validation Loss') plt.show()python.py#テストデータの正規化 X_test = X_test / 255.0 # 予測 Y_pred = model.predict(X_test) Y_pred = np.argmax(Y_pred,axis=1) print('予測データ') print(Y_pred[:5]) # カテゴリー変数の復元 Y_test_ = np.argmax(Y_test, axis=1) print('正解データ') print(Y_test_[:5]) # モデルの評価 from sklearn.metrics import classification_report print(classification_report(Y_test_, Y_pred)) 予測データ [2 6 0 2 1] 正解データ [2 5 0 9 1] precision recall f1-score support 0 0.92 0.83 0.87 93 1 0.70 0.85 0.77 100 2 0.98 0.82 0.89 99 3 0.55 0.67 0.60 103 4 0.78 0.65 0.71 117 5 0.73 0.41 0.52 93 6 0.70 0.77 0.73 101 7 0.68 0.69 0.69 110 8 0.79 0.83 0.81 88 9 0.71 0.90 0.79 96 accuracy 0.74 1000 macro avg 0.75 0.74 0.74 1000 weighted avg 0.75 0.74 0.74 1000正解率74%!!

ファインチューニングとは

学習済モデルの出力層に近い部分だけを再学習することでより作成したいモデルに適合させる。

学習済モデル(特徴抽出) → 学習済モデル(再学習) → 新しい層(畳み込み層・全結合層) → 出力層

?出力層に近い部分は、学習済データにより具体的な特徴量を持っている。そのため、この部分を再学習することで今回の学習用データにフィットした特徴量を生み出すことができる。

ファインチューニング【実装】

?前処理は転移学習を参照してください!!

python.pyfrom tensorflow.keras.applications.vgg16 import VGG16 base_model = VGG16(weights = 'imagenet', #学習済の重みを使用する include_top = False, #出力層を除外する(全結合層) input_shape = (96, 96, 3)) #入力する画像サイズ転移学習とは違い最後のConv2D層の重みを解凍して再学習します。

python.py# 最後の畳み込み層の直前までの層を固定 for layer in base_model.layers[:15]: layer.trainable = False # 重みが固定されているかの確認 for layer in base_model.layers: print(layer, layer.trainable )最後の畳み込み層のみ「True」となっていれば成功。

※「True」となっている部分が再学習される。<tensorflow.python.keras.engine.input_layer.InputLayer object at 0x7f4214e33f98> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f420a83b710> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f4209f874a8> False <tensorflow.python.keras.layers.pooling.MaxPooling2D object at 0x7f4209fb3a90> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f4209fba9e8> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f4209fb3cc0> False <tensorflow.python.keras.layers.pooling.MaxPooling2D object at 0x7f4208f3fcc0> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f4208f46dd8> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f4208f4b518> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f4208f46828> False <tensorflow.python.keras.layers.pooling.MaxPooling2D object at 0x7f4208f55eb8> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f4208f59b70> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f4208f59400> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f4208f466a0> False <tensorflow.python.keras.layers.pooling.MaxPooling2D object at 0x7f4208f659b0> False <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f4208f653c8> True <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f4208f60be0> True <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f4208f726a0> True <tensorflow.python.keras.layers.pooling.MaxPooling2D object at 0x7f4208f7ae48> Trueファインチューニングモデルの作成

python.py# VGG16のモデルに全結合分類を追加する model = keras.Sequential() # VGG16モデル model.add(base_model) model.add(Conv2D(64, kernel_size=3, padding="same", activation="relu")) model.add(MaxPooling2D()) model.add(Dropout(0.25)) model.add(Flatten()) model.add(Dense(256, activation='relu')) model.add(Dropout(0.25)) model.add(Dense(128, activation="relu")) model.add(Dropout(0.25)) model.add(Dense(64, activation="relu")) model.add(Dropout(0.5)) model.add(Dense(10, activation='softmax')) model.summary()?転移学習よりも訓練するパラメーター(Trainable params)が多くなっていることがわかる。

_________________________________________________________________ Layer (type) Output Shape Param # ================================================================= vgg16 (Functional) (None, 3, 3, 512) 14714688 _________________________________________________________________ conv2d_1 (Conv2D) (None, 3, 3, 64) 294976 _________________________________________________________________ max_pooling2d_1 (MaxPooling2 (None, 1, 1, 64) 0 _________________________________________________________________ dropout_4 (Dropout) (None, 1, 1, 64) 0 _________________________________________________________________ flatten_2 (Flatten) (None, 64) 0 _________________________________________________________________ dense_6 (Dense) (None, 256) 16640 _________________________________________________________________ dropout_5 (Dropout) (None, 256) 0 _________________________________________________________________ dense_7 (Dense) (None, 128) 32896 _________________________________________________________________ dropout_6 (Dropout) (None, 128) 0 _________________________________________________________________ dense_8 (Dense) (None, 64) 8256 _________________________________________________________________ dropout_7 (Dropout) (None, 64) 0 _________________________________________________________________ dense_9 (Dense) (None, 10) 650 ================================================================= Total params: 15,068,106 Trainable params: 7,432,842 Non-trainable params: 7,635,264 _________________________________________________________________訓練されるパラメーターの確認。

python.pyfor layer in model.layers: print(layer, layer.trainable ) print(len(model.trainable_weights))16個のパラメータで訓練が行われる。

<tensorflow.python.keras.engine.functional.Functional object at 0x7f4208f462b0> True <tensorflow.python.keras.layers.convolutional.Conv2D object at 0x7f4225e4a390> True <tensorflow.python.keras.layers.pooling.MaxPooling2D object at 0x7f40e0c9d080> True <tensorflow.python.keras.layers.core.Dropout object at 0x7f40df0d65f8> True <tensorflow.python.keras.layers.core.Flatten object at 0x7f40e0c9d7b8> True <tensorflow.python.keras.layers.core.Dense object at 0x7f40df07d780> True <tensorflow.python.keras.layers.core.Dropout object at 0x7f40e0bc2da0> True <tensorflow.python.keras.layers.core.Dense object at 0x7f40df07d978> True <tensorflow.python.keras.layers.core.Dropout object at 0x7f40df08f2e8> True <tensorflow.python.keras.layers.core.Dense object at 0x7f40df08f470> True <tensorflow.python.keras.layers.core.Dropout object at 0x7f40df083278> True <tensorflow.python.keras.layers.core.Dense object at 0x7f40df097978> True 16python.pymodel.compile(loss='categorical_crossentropy', optimizer= keras.optimizers.SGD(lr=1e-4, momentum=0.9), #ファインチューニング時は学習率が低いものを選択 metrics=['accuracy']) %%time # 学習の実施 log = model.fit_generator(train_data_gen, #学習用データ steps_per_epoch = 100, epochs = 5000, #繰り返し計算する回数 callbacks = [keras.callbacks.EarlyStopping(monitor='val_loss',#監視する値 min_delta=0, #改善とみなされる最小の量 patience=30, #設定したエポック数改善がないと終了 verbose=1, mode='auto' #監視する値が増減どうなったら終了か自動で推定 )], validation_data = valid_data_gen, #検証用データ validation_steps = 25)結果の確認

python.pyacc = log.history['accuracy'] val_acc = log.history['val_accuracy'] loss = log.history['loss'] val_loss = log.history['val_loss'] epochs_range = range(55) plt.figure(figsize=(8, 8)) plt.subplot(1, 2, 1) plt.plot(epochs_range, acc, label='Training Accuracy') plt.plot(epochs_range, val_acc, label='Validation Accuracy') plt.legend(loc='lower right') plt.title('Training and Validation Accuracy') plt.subplot(1, 2, 2) plt.plot(epochs_range, loss, label='Training Loss') plt.plot(epochs_range, val_loss, label='Validation Loss') plt.legend(loc='upper right') plt.title('Training and Validation Loss') plt.show()python.py# 予測 Y_pred = model.predict(X_test) Y_pred = np.argmax(Y_pred,axis=1) # モデルの評価 print(classification_report(Y_test_, Y_pred)) precision recall f1-score support 0 0.89 0.92 0.91 93 1 0.79 0.87 0.83 100 2 0.89 0.94 0.91 99 3 0.65 0.73 0.68 103 4 0.76 0.82 0.79 117 5 0.73 0.47 0.58 93 6 0.74 0.81 0.77 101 7 0.81 0.71 0.76 110 8 0.91 0.89 0.90 88 9 0.90 0.86 0.88 96 accuracy 0.80 1000 macro avg 0.81 0.80 0.80 1000 weighted avg 0.80 0.80 0.80 1000正解率80%!!

まとめ

転移学習:計算コスト低い・精度落ちる

ファインチューニング:計算コスト高い・精度は高い?いずれにせよGPU環境での学習でないと計算時間が非常に長くなる。

- 投稿日:2021-02-20T21:42:02+09:00

Pythonで数式を書く_01(シグモイド関数)

数式

以下がシグモイド関数(sigmoid function)です。

y\ = \frac{1}{1+e^{-ax}} \ \ (a>0)a = 1 のときは標準シグモイド関数(standard sigmoid function)と呼びます。

今回はPythonで a = 1 のときのシグモイド関数を記述します。

※ちなみに、本やネットを見ていると、y は h(x) やς(x) と表記していたりもします。Pythonで記述

import numpy as np # シグモイド関数 y = 1 / (1 + np.exp(-x))これがPythonで記述したときのシグモイド関数です。

x = 1 のときは以下のように出力されます。import numpy as np x = 1 y = 1 / (1 + np.exp(-x)) print(y)x=1の出力結果0.7310585786300049コードを省略しますが、x = -1 や x = 0 のときは以下のように出力されます。

x=-1の出力結果0.5x=0の出力結果0.2689414213699951シグモイド関数を視覚化

先ほどの入力と出力を表にまとめると次のようになります。

x = -1 x = 0 x = 1 出力結果 y 0.27 0.5 0.73 表だけだとわかりにくいですが、

グラフにするとシグモイド関数の出力は 0 ~ 1 の間になることがわかります。

ちなみに、上のグラフは以下のコードで描くことができます。

import matplotlib.pyplot as plt import numpy as np x = np.arange(-15, 15, 0.1) y = 1 / (1 + np.exp(-x)) plt.plot(x, y) plt.title("standard sigmoid function") plt.xlabel("x") plt.ylabel("y") plt.show()シグモイド関数はニューラルネットワークの活性化関数としても利用されますので、

その方面に興味のある方はシグモイド関数の数式とPythonでの記述方法を覚えておいてもよいかもしれません。

- 投稿日:2021-02-20T20:47:30+09:00

pylance(pyright)でfrom requests.packages.urllib3.util.retry import Retryに対して「reportMissingModuleSource」の警告が出る

環境

- Language Server version: 2021.2.3

- OS : Windows

- Python version 3.9

内容

インポートは正常に機能しますが

from requests.packages.urllib3.util.retry import Retryに対して「reportMissingModuleSource」の警告が出てしまう解決方法

from requests.packages.urllib3.util.retry import Retryを

from urllib3.util.retry import Retryに修正するだけ再現方法

仮想環境を作成 requestsモジュールをインポート

python -m venv venv.\venv\Scripts\activate.batpip install requestsコード

from requests.packages.urllib3.util.retry import Retry r = Retry print(r)実行

>python test.py <class 'urllib3.util.retry.Retry'>インポートは正常にできていることがわかる

「reportMissingModuleSource」の警告

pylance(pyright)では以下のような警告が出てしまう

原因調査

ソースを見てみると

requests/packages/urllib3/util/retry.pyがあると期待してたが

実際にはrequests/packages.pyのみで以下の記述があったhttps://github.com/psf/requests/blob/master/requests/packages.py

packages.pyimport sys # This code exists for backwards compatibility reasons. # I don't like it either. Just look the other way. :) for package in ('urllib3', 'idna', 'chardet'): locals()[package] = __import__(package) # This traversal is apparently necessary such that the identities are # preserved (requests.packages.urllib3.* is urllib3.*) for mod in list(sys.modules): if mod == package or mod.startswith(package + '.'): sys.modules['requests.packages.' + mod] = sys.modules[mod] # Kinda cool, though, right?これで

requests.packages.urllib3.をurllib3.に読み替えているのでimportは正常におこなえてpylanceがrequests.packages.urllib3.util.retryの実際のソースを見つけることはが出来きずに警告が出てい理由が分かるなので解決方法としてはどうせ読み替えられるので

from urllib3.util.retry import Retryでインポートするのがいいのかもしれません。ほかに解決策があれば

- 投稿日:2021-02-20T20:38:51+09:00

MonowirelessのTWELITE PalからのデータをRaspiで受け取って、DBへ格納→Streamlitで表示する

背景

タイトルの通りのことを実現したい。

イメージ図は以下の通り。

準備するもの

PC:TWELITE pal および Monostick設定変更

Raspberry pi:今回はRaspi 4(4GB)にRasbian OS を導入したものを用いました

TWILITER2:センサへの設定書き込み用

センサデータ送受信関係

TWELITE PAL(Blue or red):センサ側の通信部分(データ送信)

Ambient pal:環境センサモジュール

MONOSTICK(Blue or red):Raspi側の通信部分(データ受信)環境設定

Raspbian OS GNU/Linux 10 (buster)

Python 3.7.3

mariadb 10.3

Streamlit 0.62.0: Raspberry piでstreamlitを導入しようとするとpyarrowのインストールでコケたので0.62.0を指定しました。

mysql-connector-python 8.0.23センサのデータ送受信テスト

MONOWIRELESSさんから提供されている種々ソフトウェアを用いてセンサの送受信テストを行います。

受信側MONOSTICK(親機)およびセンサ側(子機)の設定

子機から送信されたデータを親機で受信するためには、チャンネルなどを適切に設定する必要があります。MONOWIRELESSさんが提供しているTWELITESTAGE SDKに含まれるMWSTAGEを用いて子機と親機の設定をしていきます。

今回は、Windowsにてセンサの設定を行います。続いて、DLしたTWILITESTAGE SDKを解凍します。TWILITER2をPCへと接続し、センサとTWILITER2も接続した状態で、解凍フォルダ内に含まれるTWELITESTAGE.exeを立ち上げます。

TWILITER2→アプリ書き換え→BINから選択→MONO WIRELESS APP_PAL(Endevice) V1-00-2

の順に選択するとセンサ側のファームウェアが書き込まれます。続いてインタラクティブモードへ移行するので、適宜設定します。ここでの設定の詳細は公式の解説(PALアプリインタラクティブモード)に譲ることとしますが、わからなければチャンネルをメモして、データ送信間隔を好みの感覚にいじっておけばいいでしょう。(tを入力後、好みの数字を入力)

続いて、MONOSTICKをPCへと接続し、TWELITESTAGE.exeを立ち上げます。

MONOSTICK→アプリ書き換え→BINから選択→APP_PAL-PARENT

の順に選択すると親機側のファームウェアが書き込まれます。続いてインタラクティブモードモードへ移行します。ここでは、センサ側とチャンネル設定の数字があっていることが確認できれば問題ありません。もし異なっていれば、先ほどメモした数字に書き換えましょう。Raspiを用いたデータ取得テスト

MONOWIRELESSさんによるPython用のデータ取得スクリプトを用いてセンサで取得したデータを通信によってRaspiに取得し表示するテストを行います。Raspi側では、Python3を使用するので、pyserialを導入しておきます。

>pip3 install pyserial続いて、まず、ソースコード(PAL_Script.py)と実行に必要なライブラリ(MNLib)をRaspiへと移します。

この時PAL_Script.pyとライブラリは同一のディレクトリ内に存在する必要があります。それさえ気をつけておけば、PAL_Script.pyが存在するディレクトリにおいて、>python3 PAL_Script.pyと実行しその後、子機に電池を挿入することで受信したデータが表示されます。

*** MONOWIRELESS App_PAL_Viewer 1.0.1 *** {'ArriveTime': datetime.datetime(2021, 2, 6, 21, 19, 6, 51703), 'LogicalID': 1, 'EndDeviceSID': '82014DC1', 'RouterSID': '80000000', 'LQI': 132, 'SequenceNumber': 10, 'Sensor': 128, 'PALID': 2, 'PALVersion': 1, 'Power': 2790, 'ADC1': 2373, 'Temperature': 26.85, 'Humidity': 49.06, 'Illuminance': 4}ちなみに子機側のデータ送信間隔を長く設定してしまった場合、子機のLEDの隣にあるボタンを押すと、データ送信間隔を待たずして強制的にデータが送信されます。強制送信によってもデータの送受信が確認できます。

センサのデータのMariaDBへの格納

MariaDBの導入

RaspiにMariaDBを導入します。

>sudo apt-get install mariadb-server設定周りはP.H (id:raspberrypi)さんのブログを参考にrootのパスワード設定までを実行しておきましょう。

データベースの作成

PALアプリから得られたデータを格納するためのtableを作成します。上記の通り多くのデータが無線で送信されてきますが、ここでは、センサデータとして最低限必要なものとして、

- time:受信日時(datetime) 主キーとして指定

- sensorid:センサーID(varchar(128))

- humidity:湿度(float)

- temperature:気温(float)

- lqi:受信強度(int)

を登録することとします。(カッコ内は指定する型)

>mysql -u root -p Enter password: #パスワードを入力 >create database monowireless; >create table monowireless.amb (time datetime not null primary key, sensorid varchar(128), humidity float, temperature float,lqi int);以上で必要なデータを格納するためのテーブルの作成が完了しました。

センサで取得したデータをデータベースへ登録

データ取得テストで使用したPAL_Script.pyを書き換えて取得データをデータベースへ登録します。pythonからのDB操作にはmysql-connector-pythonを用いることとします。使い方等はこちらを参考にさせていただきました。

>pip install mysql-connector-pythonまずPAL_Script.pyの冒頭のライブラリインポート部分に以下を追記します。

import mysql.connector続いて、取得したデータを記録するために、PAL_Script.py下部の「# なにか処理を記述する場合はこの下に書く」以降に、次の内容を追記します。ここに記述することでデータを取得、書き込みごとにデータベースと接続して得られたセンサデータを記録する形式となります。

conn = mysql.connector.connect( host='localhost', port='3306', user='root', password='password',#パスワード設定を変えた場合はその通りに変更 database='monowireless' ) cur = conn.cursor() cur.execute("INSERT INTO amb VALUES (%s,%s,%s,%s,%s)",(Data["ArriveTime"],Data["EndD eviceSID"] ,Data["Humidity"], Data["Temperature"],Data["LQI"])) conn.commit() cur.close() conn.close()ここまで修正したうえでPAL_Script.pyを実行し、強制送信によってデータの送受信を確認します。

>python3 PAL_Script.py受信したデータはMariaDBへ直接記録されていくので表示は出てきません。記録されたデータを確認してみます。

>mysql -u root -p Enter password: #パスワードを入力 >select * from monowireless.amb; #以下に格納されたデータが表示されるデータが確認できれば、データの格納までは完了です。

MariaDBへ格納したデータをStreamlitで表示

最後にDBに格納されたデータをStreamlitで表示しましょう。グラフ等様々な出力がありますが、ここではひとまず表形式のデータを出力することとします。

まず、streamlitの動作確認をしてみます。>streamlit helloすると、以下のようなエラーメッセージが出て怒られます。

Original error was: libf77blas.so.3: cannot open shared object file: No such file or directory調べてみるとこういう記述にぶち当たりました。どうやらライブラリが足りない模様です。

>sudo apt-get install libatlas-base-devとして必要なライブラリを導入します。これでいけるはずなので再度動作確認。

>streamlit hello RequestsDependencyWarning) Welcome to Streamlit. Check out our demo in your browser. Network URL: http://xxx.xxx.xxx.xxx:8501 External URL: http://yyy.yyy.yyy.yyy:8501 Ready to create your own Python apps super quickly? Just head over to https://docs.streamlit.io May you create awesome apps!ラズベリーパイには別のPCからsshで接続している状況を想定しています。ラズベリーパイ上で構築されたwebアプリにアクセスするにはNetwork URLに記されているURLを任意のブラウザに入力します。すると、streamlitのアプリサンプルが表示されるかと思います。確認出来たらアプリを停止して、DBからデータを取得して表示する処理を記述していきます。

amb_steamlit.pyimport mysql.connector import pandas as pd import streamlit as st def get_df_by_sql(): conn = mysql.connector.connect( host='localhost', port='3306', user='root', password='password',#パスワード設定を変えた場合はその通りに変更 database='monowireless' ) sql = 'SELECT * FROM amb' df = pd.io.sql.read_sql(sql,conn) conn.close return df st.table(get_df_by_sql())上記をsteramlitで実行します。

>streamlit run amb_steamlit.pyテスト時と同様に得られたURLに接続すると以下のような画面になります。

無事streamlitで取得データを表示することができました。

まとめ

以上で、「MonowirelessのTWELITE PalからのデータをRaspiで受け取って、DBへ格納→Streamlitで表示する」ことができました。グラフ等にしたければStreamlitの書式に従って適宜作っていきましょう。

参考

MONOWIRELESS

Raspberry Pi & Python 開発ブログ ☆彡

DBOnline MySQLの使い方

Qiita Python + mysql-connector-python の使い方まとめ

- 投稿日:2021-02-20T20:37:43+09:00

Github Actions 使ったらPypiへのリリースがめちゃくちゃ楽になった

Github Actions 使ったらめちゃくちゃ楽になった

Python Packageのリリース (Pypi)

https://github.com/tys-hiroshi/backlogprocessing を例に挙げると、

今まで、setup.cfg ファイルの

versionパラメータを修正し、

以下のコマンドをUbuntuで叩いていた。pipenv shell pipenv install --dev twine python3 setup.py sdist --formats=zip twine upload dist/*GithubからCloneしてこないといけないし、Releaseできる環境が常にあるわけではないので、

それなりにしんどい作業だった。.github/workflos/[名前は何でも良いよ].yml

を作成し、以下のように記載すると、PypiへReleaseできる。

PYPI_API_TOKEN は Pypiで発行したAPI TokenをGithubのSecretsに登録すること!

name: Upload pypi package release on: # Trigger the workflow on push or pull request, # but only for the master branch push: branches: - master release: types: - created jobs: deploy: runs-on: ubuntu-latest steps: - uses: actions/checkout@v2 - name: Set up Python uses: actions/setup-python@v2 with: python-version: '3.x' - name: Install dependencies run: | python -m pip install --upgrade pip pip install pipenv pip install wheel - name: Build run: | python3 setup.py sdist --formats=zip - name: Publish a Python distribution to PyPI if: startsWith(github.event.ref, 'refs/tags') || github.event_name == 'release' uses: pypa/gh-action-pypi-publish@master with: user: __token__ password: ${{ secrets.PYPI_API_TOKEN }}Thank you for Reference:

https://help.github.com/en/actions/reference/events-that-trigger-workflows

- 投稿日:2021-02-20T19:30:17+09:00

Macのpyenv installエラー

環境

- MacOSX 11.2.1 BigSur

エラー内容

MacOSXでのzlibエラー。

pyenv install 3.8.5を叩くとエラーがでた。$ pyenv install 3.8.5errorpython-build: use openssl@1.1 from homebrew python-build: use readline from homebrew Installing Python-3.8.5... python-build: use readline from homebrew python-build: use zlib from xcode sdk BUILD FAILED (OS X 11.2.1 using python-build 20180424)ログのtailはこんな感じ。

log__import__(pkg_name) File "<frozen zipimport>", line 241, in load_module File "<frozen zipimport>", line 709, in _get_module_code File "<frozen zipimport>", line 570, in _get_data zipimport.ZipImportError: can't decompress data; zlib not available make: *** [install] Error 1対処法

Tipsによく転がっているxcode-selectや、pkgのインストールなどではうまくいかなかったが、下記でうまくいった。

LDFLAGS="-L$(xcrun --show-sdk-path)/usr/lib" pyenv install 3.8.5参考にした記事

こちらの記事に書いてあった。

https://github.com/pyenv/pyenv/issues/1219#issuecomment-727951276

- 投稿日:2021-02-20T19:30:17+09:00

pyenv installしたときのZipImportError

環境

- MacOSX 11.2.1 BigSur

エラー内容

MacOSXでのzlibエラー。

pyenv install 3.8.5を叩くとエラーがでた。$ pyenv install 3.8.5errorpython-build: use openssl@1.1 from homebrew python-build: use readline from homebrew Installing Python-3.8.5... python-build: use readline from homebrew python-build: use zlib from xcode sdk BUILD FAILED (OS X 11.2.1 using python-build 20180424)ログのtailはこんな感じ。

log__import__(pkg_name) File "<frozen zipimport>", line 241, in load_module File "<frozen zipimport>", line 709, in _get_module_code File "<frozen zipimport>", line 570, in _get_data zipimport.ZipImportError: can't decompress data; zlib not available make: *** [install] Error 1対処法

Tipsによく転がっているxcode-selectや、pkgのインストールなどではうまくいかなかったが、下記でうまくいった。

LDFLAGS="-L$(xcrun --show-sdk-path)/usr/lib" pyenv install 3.8.5参考にした記事

こちらの記事に書いてあった。

https://github.com/pyenv/pyenv/issues/1219#issuecomment-727951276

- 投稿日:2021-02-20T17:46:20+09:00

Python ExcelデータをGoogle翻訳からスクレイピング翻訳

0. はじめに

以前YouTubeで紹介した仕事や課題のさぼり方について解説する。エクセルに羅列された日本語を英語に翻訳するプログラムだ。WebDriverを用いてgoogle翻訳からスクレイピングで翻訳する。動作環境はChromで行う。

1. 必要ライブラリ

openpyxl、selenium、timeを用いる。openpyxlとseleniumは予めpip等でインストールする必要がある。又、ブラウザ操作をするためChromDriverをダウンロードしpathを通しておく必要がある。python -m pip install openpyxl python -m pip install seleniumimport openpyxl as excel from selenium import webdriver import time2. Excelファイルの読み込みとDriverの設定

次にエクセルファイルを指定する。

book = excel.load_workbook("<Excelファイルのパス>", data_only=True) sheet = book.worksheets[0] #データのsheetを選択 driver = webdriver.Chrome() #DriverをChromに設定 count = 1 #セルの行指定3. データの読み込みとスクレイピングによる翻訳

先ほどを見込んだファイルからセルのデータを抽出し、Google翻訳で英訳する。返ってきた英語を受け取りExcelに書き込む。

while True: cell = sheet["A" + str(count)] #cellの指定 if cell.value: #もしcellにデータがあれば url = "https://translate.google.co.jp/?hl=ja&sl=ja&tl=en&text={}&op=translate".format(cell.value) #Google翻訳に日本語を入力済みのURLを作成 driver.get(url) #上記URLを開く time.sleep(1) #サーバ負荷軽減 ja = driver.find_element_by_css_selector("span[jsname='W297wb']") sheet["B" + str(count)] = ja.text count += 1 else: break #cellにデータがなければループを抜ける4. Excelファイルを保存し実行

最後にExcelファイルを保存する。

実際にデバッグしてみるとChromが立ち上がり順次翻訳されるだろう。デバッグする際はExcelファイルは閉じてデバッグする。book.save("<Excelファイルのパス>")5. 最後に

課題をさぼれるが何の役にも立たない。課題はしっかりやって身に着けるべき。

- 投稿日:2021-02-20T17:41:01+09:00

Pythonコードと可視化で確認するマハラノビス距離

はじめに

この記事ではマハラノビス距離の計算と可視化を通して、

マハラノビス距離を用いた異常検知のイメージを確認します。

理論や数式は省いて、ソースコードと可視化を中心に、定性的な理解に重きを置いています。この記事ですること

・相関のあるデータの生成と可視化

・分散共分散行列の計算と可視化

・マハラノビス距離の計算と可視化マハラノビス距離の定義等については、既にQiita内でも解説してくださっている方がいらっしゃるので、

そちらを参考にされると良いと思います。

教師なし学習による異常値検知: マハラノビス距離 (理論編)

scipyを使って特徴量の相関を考慮したマハラノビス距離を計算するscikit-learnでの公式ページの解説はこちらからご確認ください。

Robust covariance estimation and Mahalanobis distances relevance本論

ライブラリ

バージョン確認

import numpy import matplotlib import scipy import sklearn print("numpy: {0}".format(numpy.__version__)) print("matplotlib: {0}".format(matplotlib.__version__)) print("scipy: {0}".format(scipy.__version__)) print("sklearn: {0}".format(sklearn.__version__))筆者環境では以下のバージョンがインストールされております。

numpy: 1.17.0 matplotlib: 3.2.2 scipy: 1.5.0 sklearn: 0.23.1使用する部分のインポート

import numpy as np import matplotlib.pyplot as plt from scipy.stats import multivariate_normal from sklearn.covariance import EmpiricalCovariance相関のあるデータの生成と可視化

今回は正の相関を持つ2次元正規分布のデータを生成して学習データとして利用します。

分散をそれぞれ1.0、共分散を0.7に設定しています。mean = np.array([0,0]) # 平均 cov_org = np.array([[1.0,0.7],[0.7,1.0]]) # 分散共分散行列 np.random.seed(0) X = multivariate_normal(mean, cov_org).rvs(size=1000) # データ生成生成したデータを散布図で可視化します。

fig,ax = plt.subplots(figsize=(8,6)) ax.plot(X[:,0], X[:,1] ,'.') ax.set_xlim([-4,4]) ax.set_ylim([-4,4]) ax.set_xlabel('X[0]') ax.set_ylabel('X[1]') ax.set_aspect('equal') ax.set_title('Fig.1') plt.savefig('fig1.png')正の相関を持つデータが生成できていることが確認できます。

分散共分散行列の計算と可視化

生成したデータから分散共分散行列を再計算してみます。

これがデータの「学習」に相当します。empCov = EmpiricalCovariance().fit(X) cov_cal = empCov.covariance_ヒートマップで可視化してみます。

fig, ax = plt.subplots(figsize=(8,6)) im = ax.imshow(cov_cal, vmin=0, cmap='Reds') cbar = ax.figure.colorbar(im, ax=ax) ax.set_xticks(np.arange(cov_cal.shape[0])) ax.set_yticks(np.arange(cov_cal.shape[1])) ax.tick_params(top=True, bottom=False,labeltop=True, labelbottom=False) for i in range(cov_cal.shape[0]): for j in range(cov_cal.shape[1]): text = ax.text(i, j, cov_cal[i, j], ha='center', va='center', color='w') ax.set_title('Fig.2') plt.savefig('fig2.png')

データの生成時に設定した分散共分散行列に従ってデータが生成されていることが確認できます。マハラノビス距離の計算と可視化

テスト用にデータを生成します。

今回は[-2,-2]~[2,2]の範囲で1間隔の格子状にデータを生成しています。

説明の都合上、A:[-2,-2],B:[-1,-2],C:[0,-2],…,M:[0,0],…,Y:[2,2]と対応付けることにします。Y0,Y1 = np.meshgrid(np.arange(-2,3),np.arange(-2,3)) Y = np.array([Y0.reshape(-1),Y1.reshape(-1)]).T labels = ['A','B','C','D','E','F','G','H','I','J','K','L','M','N','O','P','Q','R','S','T','U','V','W','X','Y']これを先ほど使用したEmpiricalCovarianceクラスのmahalanobis()に入れるとマハラノビス距離の2乗が計算できます。

md = np.sqrt(empCov.mahalanobis(Y)) print('Mahalanobis Distance') print(md)実行結果

Mahalanobis Distance [2.24902063 2.12256063 2.84114155 3.96970512 5.25020799 2.16386194 1.13576907 1.42031549 2.61997568 3.97880646 2.88870249 1.45353983 0.0246127 1.41706927 2.85223012 4.00562162 2.64077329 1.42197552 1.09086983 2.11604144 5.27100616 3.98405422 2.84280177 2.10000179 2.20412 ]棒グラフで可視化するとこのようになります。

fig,ax = plt.subplots(figsize=(8,6)) ax.bar(labels, md) ax.set_xlabel('Label') ax.set_ylabel('Mahalanobis Distance') ax.set_title('Fig.3') plt.savefig('fig3.png')この結果を詳しく見ていくことにします。

先ほどの散布図に、テスト用データおよびラベルと、マハラノビス距離の等高線も含めて可視化します。### 等高線用データ cX, cY = np.meshgrid(np.linspace(-4, 4, 100), np.linspace(-4.0, 4.0, 100)) cZ = np.sqrt(empCov.mahalanobis(np.array([cX.reshape(-1),cY.reshape(-1)]).T)).reshape(100,100) ### 散布図 + 等高線 fig,ax = plt.subplots(figsize=(8,6)) # 学習データ ax.plot(X[:,0], X[:,1], '.', alpha=0.3) # テストデータ ax.plot(Y[:,0], Y[:,1], 'x', color='red') # 等高線用データ ax.clabel(ax.contour(cX, cY, cZ, np.arange(0, 10, 1), cmap='jet'), inline=True, fontsize=10) for i in range(Y.shape[0]): text = ax.text(Y[i,0]+0.1, Y[i,1]+0.1, labels[i], color='r') ax.set_xlim([-4,4]) ax.set_ylim([-4,4]) ax.set_xlabel('X[0]') ax.set_ylabel('X[1]') ax.set_aspect('equal') ax.set_title('Fig.4') plt.savefig('fig4.png')M[0,0]の点は分布の中央に位置しているので、マハラノビス距離はほぼ0となります。

つまり、異常度は極めて低いと言うことができます。

E[2,-2]とU[2,-2]が相関から外れているため、マハラノビス距離が5.3程度と大きくなっています。

そのため、例えば「マハラノビス距離5以上を異常とみなす」と設定した場合は、

E・Uの2点を異常として検知することができます。

また、A[-2,-2]とE[2,-2]を比べてみると、中心からの画像上の距離(=ユークリッド距離)は同じですが、

Aの方は相関から外れていないのでマハラノビス距離も2.2と小さくなっています。

他に、A[-2,-2]とI[1,-1]を比べてみると、ユークリッド距離が小さいのはIですが、相関から外れているため、

マハラノビス距離は2.6とAより大きくなっています。

以上のように相関を考慮した異常検知ができていることが確認できると思います。まとめ

以上、コードと可視化を交えたマハラノビス距離の解説でした。

どなたかのお役に立てれば幸いです。

お気づきの点がありましたらご指摘ください。付録

使用したコード全体

## ライブラリ ### バージョン確認 import numpy import matplotlib import scipy import sklearn print("numpy: {0}".format(numpy.__version__)) print("matplotlib: {0}".format(matplotlib.__version__)) print("scipy: {0}".format(scipy.__version__)) print("sklearn: {0}".format(sklearn.__version__)) ### 使用する部分のインポート import numpy as np import matplotlib.pyplot as plt from scipy.stats import multivariate_normal from sklearn.covariance import EmpiricalCovariance ## データの生成と可視化 ### データの生成 mean = np.array([0,0]) # 平均 cov_org = np.array([[1.0,0.7],[0.7,1.0]]) # 分散共分散行列 np.random.seed(0) X = multivariate_normal(mean, cov_org).rvs(size=1000) # データ生成 ### 散布図 fig,ax = plt.subplots(figsize=(8,6)) ax.plot(X[:,0], X[:,1] ,'.') ax.set_xlim([-4,4]) ax.set_ylim([-4,4]) ax.set_xlabel('X[0]') ax.set_ylabel('X[1]') ax.set_aspect('equal') ax.set_title('Fig.1') plt.savefig('fig1.png') ## 分散共分散行列の計算と可視化 ### 分散共分散行列の再計算(学習) empCov = EmpiricalCovariance().fit(X) cov_cal = empCov.covariance_ ### ヒートマップ fig, ax = plt.subplots(figsize=(8,6)) im = ax.imshow(cov_cal, vmin=0, cmap='Reds') cbar = ax.figure.colorbar(im, ax=ax) ax.set_xticks(np.arange(cov_cal.shape[0])) ax.set_yticks(np.arange(cov_cal.shape[1])) ax.tick_params(top=True, bottom=False,labeltop=True, labelbottom=False) for i in range(cov_cal.shape[0]): for j in range(cov_cal.shape[1]): text = ax.text(i, j, cov_cal[i, j], ha='center', va='center', color='w') ax.set_title('Fig.2') plt.savefig('fig2.png') ## マハラノビス距離の計算と可視化 ### テスト用データ生成(格子点) Y0,Y1 = np.meshgrid(np.arange(-2,3),np.arange(-2,3)) Y = np.array([Y0.reshape(-1),Y1.reshape(-1)]).T labels = ['A','B','C','D','E','F','G','H','I','J','K','L','M','N','O','P','Q','R','S','T','U','V','W','X','Y'] ### マハラノビス距離計算 md = np.sqrt(empCov.mahalanobis(Y)) print('Mahalanobis Distance') print(md) ### 棒グラフ fig,ax = plt.subplots(figsize=(8,6)) ax.bar(labels, md) ax.set_xlabel('Label') ax.set_ylabel('Mahalanobis Distance') ax.set_title('Fig.3') plt.savefig('fig3.png') ### 等高線用データ cX, cY = np.meshgrid(np.linspace(-4, 4, 100), np.linspace(-4.0, 4.0, 100)) cZ = np.sqrt(empCov.mahalanobis(np.array([cX.reshape(-1),cY.reshape(-1)]).T)).reshape(100,100) ### 散布図 + 等高線 fig,ax = plt.subplots(figsize=(8,6)) # 学習データ ax.plot(X[:,0], X[:,1], '.', alpha=0.3) # テストデータ ax.plot(Y[:,0], Y[:,1], 'x', color='red') # 等高線用データ ax.clabel(ax.contour(cX, cY, cZ, np.arange(0, 10, 1), cmap='jet'), inline=True, fontsize=10) for i in range(Y.shape[0]): text = ax.text(Y[i,0]+0.1, Y[i,1]+0.1, labels[i], color='r') ax.set_xlim([-4,4]) ax.set_ylim([-4,4]) ax.set_xlabel('X[0]') ax.set_ylabel('X[1]') ax.set_aspect('equal') ax.set_title('Fig.4') plt.savefig('fig4.png')

- 投稿日:2021-02-20T17:15:40+09:00

【Python】2次元配列で隣接している座標を求める その1【NumPy】

Python 勉強中です

時間があるので Python の勉強をしています。NumPyってのが、いい感じにややこしくて、おもしろいなぁ。というレベル感の記事です。Google Colaboratory で動作させながら記事を書いてます。

数学的な知見があまりないので「Numpy 隣接」などで検索してもそれじゃない感じの概念の解説しかみつけられなかったので、自分で考えてみたので残しておこうと思います。

ゲーム系のプログラマーでもないし座標計算?な、ゆるい記事です。まずは2次元配列を作成して表示する。

import numpy as np l = np.arange(15).reshape(3,5) print(l) # [[ 0 1 2 3 4] # [ 5 6 7 8 9] # [10 11 12 13 14]]これだけで簡単にできるのはなかなか嬉しい。Python, NumPy が人気なのも納得。

まずは

6に隣接する1,5,7,11を求めていきます。

6の座標は(1,1)です。上下左右とはそれぞれ(-1,0)(+1,0)(0,-1)(0,+1)を座標と演算して(0,1)(2,1)(1,0)(1,2)ですね。

ファーストステップは点pから4つの座標がわかるところまで。可読性がいいかなと思い、座標はタプルを利用します。p = (1,1) print( l[p], l[(0,1)], l[(2,1)], l[(1,0)], l[(1,2)] ) # 6 1 11 5 7最初の呪文「ブロードキャスト!」

ここで早速、NumPyさんの呪文「ブロードキャスト」が活躍しそうです。

細かい解説はしませんが、要素が一つのものと複数のものとを演算するといい感じにしてくれる呪文だと思っています。

そもそも(1,1)+(0,1)で(1,2)を簡単に求めてくれるのも NumPyさんのおかげ。以下にコードをprint( p + (0,1) ) # (1, 1, 0, 1) # 通常タプル同士の + はただ連結される print( p + np.array((0,1)) ) # [1 2] # どちらかがNumPy化?しているとそれぞれ足してくれる。不思議! # Up Right Down Left # 時計回り u_r_d_l = [(-1,0), (0,1), (1,0), (0,-1)] print( p + np.array(u_r_d_l) ) # [[0 1] # [1 2] # [2 1] # [1 0]] # アメージング!for文っぽいループなしに4つの座標の演算結果をゲットすることができました。コメントでNumPy化という謎の言葉を使いましたが、みんなどんな感じで呼んでますか?うちらはこうだな、などなどありましたらぜひコメントください。

おもしろいと感じたのは「+」の前後どちらかだけでもうまくいくところですね。ちなみに座標部分はタプル

(1,1)で記述していますが、リスト[1,1]でも問題ないはずです。座標を扱う際にタプル(a,b)に特別な機能があるわけではない(と思う)。同じように Python 勉強中の方がいたら混乱するかもしれないので、念のため言及しておきます。断言してないのはまだ僕も勉強中で書いている記事なので。また演算結果はタプルではなくなってしまいますが

[*map(tuple, xxx)]で、xxx に入れるとタプルを持ったリストに変換できます。わざわざタプルにする必要がない場合も、print()で表示したときに見やすいかもなって時などに、この方法を利用していきます。

map関数?はっ?て人も、このコードは[[],[],...]を[(),(),...]に変換してるんだなぐらいで考えてればOKです。(この記事では map関数の説明をする気がないです。。。ごめんなさい。ちなみにどなたか詳しい方でlist(map(...))と[*map(...)]の違いってあるのか、ご教授いただけたら嬉しいです。)# [[],[],...] → [(),(),...] へ変換 print( [*map(tuple, p + np.array(u_r_d_l)] ) # [(0, 1), (1, 2), (2, 1), (1, 0)]これでかんせーい!ではないですね。

今は点p が中心あたりなので大丈夫ですが、これがはじっこにずれると範囲外の座標を示してしまいます。

(-1,0)などのマイナス座標は Pythonはうまい具合に後ろから処理してくれますが、(3,0)や(0,5)はエラーになってしまいます。

次の呪文で、この辺りのケアをしていきたいと思いますが、ここまでのコードをちょっと書き換えて一度、記述しておきます。まぁまぁなことやってるはずなのですが、短くてすごいですね。

2次元配列に壁の概念があって、点p にはじっこが入力されない場合はこれでおしまいですからね。import numpy as np l = np.arange(15).reshape(3,5) p = (1,1) u_r_d_l = np.array([(-1,0), (0,1), (1,0), (0,-1)]) print( [*map(tuple, p + u_r_d_l] ) # [(0, 1), (1, 2), (2, 1), (1, 0)]思ってたよりこの後が長くなっているので、一度投稿しておきます。 つづく

- 投稿日:2021-02-20T16:42:47+09:00

kivyに関する備忘録

Androidアプリを作っている際にpythonでGUIを作成したいなと思ったので、kivyというライブラリを使ってGUIを作成することにしました!

今回はメモ代わりに書いているので、正直書いている項目に順番はありません。また、今回は

Widgetクラスとウィジェットを区別して書くことにします。カタカナでウィジェットになっている場合は、ButtonやLabelなどのウィジェットだと思ってください。開発環境

- Visual Studio Code 1.53.2

- MacOS Darwin x64 20.3.0

- python 3.7.7(anaconda)

参考記事

こちらの記事がわかりやすかったので、参考にさせていただきました。

Kivy 超入門(6):動的配置 – float レイアウト

Python: Kivy と Matplotlib でデータセットの確認ツールを書いてみる

Kv Languageを使ったKivyの動かし方

Kv言語の基本

Python: Kivy で Matplotlib のグラフをプロットする

Python3入門〜Kivy による GUI アプリケーション開発,サウンド入出力,ウェブスクレイピング〜GUIを構築するためのプログラミング言語

まず、最初にAndroidアプリを作る時には、Androidアプリを作るための統合開発環境である、Android Studioというものが良く使われているみたいです。

しかし、これで作る場合は、言語はJavaかKotlinというもので作る必要があるのですが、自分はPythonで書く方が慣れているため、なんとかpythonで作る方法を探してみたところ、見つかったのが、このkivyというライブラリです。

kivyの役割

kivyライブラリを使って、GUIを作成する際は、

①pythonファイルだけを作成して、そこにkivyライブラリを読み込んで、GUIを作っていく方法

②pythonファイルとkvファイルの2つを作成して、pythonファイルには機能だけを、kvファイルにはレイアウトだけを加えていき、GUIを作成していく方法(この場合もpythonファイルにはkivyライブラリを読み込む)②の場合は、HTMLとCSSのような書き方になっておりますね。

日本語表記するための最強のライブラリ

KV Languageを使って日本語表記を行おうと思っている方は多いと思います。

しかし、kvはデフォルトでは英語表記になっておりますので、日本語表記にするために色々面倒くさそうなことをしなければありません。そこで活躍するのが、

japanize_kivyになります!!pip install japanize-kivy import japanize_kivyこれを行うだけで、他には何もしなくても日本語で表示することが可能です。

Python: インポートするだけで Kivy が日本語を表示できるようになる japanize-kivy を作った

Widgetとは

まず、Kivyを勉強していて思ったのが、

Widgetクラスを親クラスとして継承して、Buttonなどを作っている人もいれば、継承せずに作っている人もいるという不思議。どうやら、Widgetクラスとは

ButtonやLabelなどの総称のことではないかと自分は理解しました。

なので、Widgetクラスを継承しておけば、他を包括しているので、万能!みたいな感じかなと。ルートウィジェットとは

ウィジェットのことは少しわかったのですが、次によくわからなかった部分が、

ルートウィジェットになります。ズバリ結論から言いますと、

ルートウィジェットというのは、全てのウィジェットの1番基盤の部分になります。少しわかりにくいと思いますので、具体例を見ながら確認していきましょう。

Application.pyfrom kivy.app import App from kivy.uix.widget import Widget class MyWidget(Widget): pass class MyApp(App): def build(self): return MyWidget() if __name__ == '__main__': MyApp().run()こちらの

pythonファイルの方で、Widgetクラスを継承して、新しいMyWidgetクラスを作成しています。my.kv<MyWidget>: BoxLayout: orientation: 'vertical' Label: GridLayout: rows:1 cols:4 Button: Button: Button: Button:上の場合ですと、

ルートウィジェットというのは、MyWidgetになります。

ルートウィジェットというのはアプリケーションのなかに、必ず1つだけしか存在しないという特徴があります。

MyWidgetという1番大きなWidgetを定義する- その中に

BoxLayoutという2番目に大きなWidgetを定義するBoxLayoutの中に、LabelやGridLayoutやButtonなどの細かいウィジェットが入っているこのような構造になっております。

MyWidgetが親だとすると、BoxLayoutは子ども、LabelやGridLayout

やButtonは孫みたいな感じになりますね。selfとrootの違い

先程のコードのkvファイルのみを用いて説明をしたいと思います。

my.kv<MyWidget>: BoxLayout: orientation: 'vertical' Label: GridLayout: rows:1 cols:4 Button: Button: Button: Button:まず、

selfとは個々のウィジェット自身を指します。

GridLayoutの部分にself.を書けば、GridLayout自身を指しますし、Button

の部分に書けば、Button自身を指します。次に

rootですね。

正直、rootに関してはあまり確信を持てていない状態です。

個人的な認識としては、rootウィジェットを指していると考えております。確信を持てていない理由

なぜ、確信を持てていないのかというと、例えば、下で説明するような画面の切り替えを行う場合に、rootは結局1番根っこの

rootウィジェットを指しているのか、それともrootウィジェットに追加されたウィジェットを指しているのかわからないからです。pos_hintとsize_hint

アプリケーションを作るということになった場合、PCとスマホで画面の大きさが違うという問題にぶち当たりますよね。

通常は、以下のように、

ピクセル単位で数字を指定していくのですが、これだと、PCの時は良いかもしれないが、スマホの時はサイズが合わないというふうになってしまいます。pos: 20, 50 size: 500, 300そこで、活躍してくれるのが、

pos_hintとsize_hintというものになります。pos_hint: {'x':0, 'top':1} size_hint: 0.3, 0.4のような形で、

size_hintは全画面に対してどれくらいの割合の大きさか、pos_hintは画面の左下を(0,0)として、どれくらいの割合の場所に位置するかというのを指定します。pos_hintの変数

pos_hintはx, y, right, topを変数として指定することができます。xはウィジェットの左の部分の位置を指定

yはウィジェットの下部分の位置を指定

rightはウィジェットの右部分の位置を指定

topはウィジェットの上部分の位置を指定を行うことができます。

root.sizeとhint_sizeはどう使い分ければ良い?

個人的によくわかりにくかったのが、この2つを使い分けることですね。

root.sizeは1番大きい外枠のWidgetの大きさを基準にするhint_sizeは今現在のWidgetの大きさを基準にする少し文字だとわかりにくいので、具体例を使って説明していきたいと思います。

Application.pyfrom kivy.app import App from kivy.uix.widget import Widget class MyWidget(Widget): pass class MyApp(App): def build(self): return MyWidget() if __name__ == '__main__': MyApp().run()my.kv<MyWidget>: BoxLayout: orientation: 'vertical' size: root.size Label: id: txt01 text: root.text size_hint: 1, 0.1

BoxLayoutでまず、root.sizeを使用しているのですが、これは、ルートウィジェットの大きさまで大きくするという認識で考えております。

Labelの方で、size_hintを使用していますが、こちらは、Labelより1つ外側のWidget(今回は、BoxLayout)の大きさを基準にして、調整する形になります。もしも、

Labelでroot.sizeを使った場合は、MyWidgetの大きさのLabelができあがります。(間違っていたらすみません。)つまづいた点

こちらは、GUIアプリを作っている際に、つまづいて、Teratailにも質問してみた内容です。

Application.pyimport japanize_kivy import pandas_datareader.data as web import numpy as np import matplotlib.pyplot as plt import datetime import talib import mplfinance as mpf import time import pandas as pd import tensorflow as tf import schedule import traceback import sys from sklearn import preprocessing from StockApp import * from matplotlib import gridspec from kivy.app import App from kivy.config import Config from kivy.uix.widget import Widget from kivy.uix.boxlayout import BoxLayout from kivy.properties import * from kivy.resources import resource_add_path from kivy.core.text import LabelBase, DEFAULT_FONT from kivy.uix.screenmanager import ScreenManager, Screen from kivy.garden.matplotlib.backend_kivyagg import FigureCanvasKivyAgg from kivy.graphics import * from kivy.factory import Factory # マルチタッチを無効化する => 右クリックしても赤い点が残らない Config.set('input', 'mouse', 'mouse, disable_multitouch') Config.set('modules', 'inspector', '') Name = ['A', 'B'] # csvファイルを読み込む Hello01 = pd.read_csv('graph01.csv') Hello02 = pd.read_csv('graph02.csv') Hello03 = pd.read_csv('graph03.csv') Hello01['Date'] = pd.to_datetime(Hello01['Date']) Hello02['Date'] = pd.to_datetime(Hello02['Date']) Hello03['Date'] = pd.to_datetime(Hello03['Date']) # DataFrameの状態では、インデックス番号で指定できないからnp.arrayで配列に変換する A_Hello = np.array(Hello01).T B_Hello = np.array(Hello02).T C_Hello = np.array(Hello03).T class FirstPage(BoxLayout): text = StringProperty() # プロパティの追加 graph = NumericProperty(0) def __init__(self, *args, **kwargs): super().__init__(*args, **kwargs) self.text = ' ' # リストに入れる self.d_list = [] self.w_list = [] self.m_list = [] self.numbers = 0 with open('File01.txt', 'r', encoding='utf-8') as day: self.day = day.readlines() with open('File02.txt', 'r', encoding='utf-8') as week: self.week = week.readlines() with open('File03.txt', 'r', encoding='utf-8') as month: self.month = month.readlines() # ActionBarの次へボタンを押したら次の会社に行くようにする処理 def Next(self, index_num): if 0 <= index_num < len(Name) - 1: self.numbers = index_num self.text = self.day[self.numbers] # 月のグラフの表示を更新する処理 def update01(self): self.text = self.month[self.numbers] # 週のグラフの表示を更新する処理 def update02(self): self.text = self.week[self.numbers] # 日の表示を更新する処理 def update03(self): self.text = self.day[self.numbers] class GraphView(BoxLayout): def __init__(self, *args, **kwargs): super().__init__(*args, **kwargs) # データをrootウィジェットの方に呼び出すようにする => このクラスがインスタンス化された時に1番最初に呼び出される self.A_Hello = A_Hello self.B_Hello = B_Hello self.C_Hello = C_Hello self.d_data = Hello01 self.w_data = Hello02 self.m_data = Hello03 self.num = 0 # figとaxだけで表す必要あり self.fig, self.ax = plt.subplots(2, 1, gridspec_kw={ 'height_ratios':[4,1] }) self.Update(self.A_Hello[self.num+1], self.d_data[Name[self.num]], Hello['Date']) self.add_widget(FigureCanvasKivyAgg(self.fig)) def Update(self, data, signal, times): # 前にプロットされたグラフを消去する self.ax[0].clear() self.ax[1].clear() period = 30 upper, middle, lower = talib.BBANDS(signal, timeperiod=period, nbdevup=1, nbdevdn=1, matype=0) # 引数としてHelloを取得するからselfをつける必要はない rsi = talib.RSI(signal, timeperiod=period) # 取得したデータを元にプロットする self.ax[0].plot(times, data) self.ax[0].set_ylabel('price', fontsize=15) self.ax[0].plot(times, upper) self.ax[0].plot(times, lower) self.ax[0].legend([Name[self.num]]) self.ax[0].tick_params(labelsize=10) self.ax[1].plot(times, rsi) self.ax[1].set_xlabel('time', fontsize=20) self.ax[1].set_ylabel('persentage', fontsize=15) self.ax[1].legend(['RSI']) self.ax[1].tick_params(labelsize=10) # 再描画する self.fig.canvas.draw() self.fig.canvas.flush_events() time.sleep(0.1) # 0.1秒だけ開ける # ActionBarの次へボタンを押したら次に行くようにする処理 def Next(self, index_num): if 0 <= index_num < len(Name) - 1: self.num = index_num A_Hello = self.A_Hello[self.num+1] data = self.d_data[Name[self.num]] self.Update(A_Hello, data, Hello['Date']) # 月のグラフの表示を更新する処理 def update01(self): C_Hello = self.C_Hello[self.num+1] m_data = self.m_data[Name[self.num]] self.Update(C_Hello, m_data, Hello03['Date']) # 上で変更された変数を元にしてメソッドが実行される # 週のグラフの表示を更新する処理 def update02(self): B_Hello = self.B_Hello[self.num+1] w_data = self.w_data[Name[self.num]] self.Update(B_Hello, w_data, Hello02['Date']) # 日毎の表示を更新する処理 def update03(self): A_Hello = self.A_Hello[self.num+1] d_data = self.d_data[Name[self.num]] self.Update(A_Hello, d_data, Hello['Date']) class TextWidget(Widget): sm = ScreenManager() print(Name[0]) def __init__(self, *args, **kwargs): super().__init__(*args, **kwargs) def change_page(self): self.clear_widgets() self.add_widget(FirstPage()) def change_page2(self): self.clear_widgets() page2 = Factory.SecondPage() self.add_widget(page2) class CopyHelloApp(App): def __init__(self, **kwargs): super().__init__(**kwargs) self.title = 'HelloWold' # ウィンドウの名前を変更する def build(self): return TextWidget() if __name__ == '__main__': CopyHelloApp().run()copyhello.kv#:kivy 2.0.0 # TextWidget rootウィジェットに指定されている TextWidget: <TextWidget>: FirstPage: id: page1 <page1>: orientation: 'vertical' size: root.size # BoxLayoutのサイズ rootウィジェット(TextWidget)の大きさに合わせる # メニューバー ActionBar: ActionView: ActionPrevious: title: 'ページタイトル1' with_previous: False # 戻るボタンを表示する ActionButton: text: '次のページ' on_release: app.root.change_page2() ActionGroup: text: 'グループ名' mode: 'spinner' ActionButton: text: 'A' on_release: app.root.ids['graph_view'].Next(0) on_release: app.root.ids['page1'].Next(0) on_release: name.text = 'A' ActionButton: text: "B" on_release: app.root.ids['graph_view'].Next(1) on_release: app.root.ids['page1'].Next(1) on_release: name.text = 'B' BoxLayout: orientation: 'horizontal' size_hint_y: 0.1 Label: id: name text: 'A' Label: id: show text: app.root.ids['page1'].text # グラフをここで表示する GraphView: size_hint_y: 0.9 id: graph_view GridLayout: cols: 3 rows: 1 size_hint_y: 0.1 Button: id: button11 text: '月' font_size: 48 on_release: app.root.ids['graph_view'].update01() on_release: app.root.ids['page1'].update01() Button: id: button12 text: '週' font_size: 48 on_release: app.root.ids['graph_view'].update02() on_release: app.root.ids['page1'].update02() Button: id: button13 text: '日' font_size: 48 on_release: app.root.ids['graph_view'].update03() on_release: app.root.ids['page1'].update03() <GraphView>: <SecondPage@BoxLayout>: id: page2 size: root.size orientation: 'horizontal' # 画面の切り替えを行う ActionBar: ActionView: ActionPrevious: title: 'ページタイトル2' with_previous: False # 戻るボタンを表示する ActionButton: text: '前のページ' on_release: app.root.change_page() MyLabel: id: first_button text: 'Hello' MyLabel: id: second_button text: 'World' <MyLabel@Label>: font_size: 60 size_hint_y: 1 '''このコードですと、なぜか画面が真っ暗になってしまったので、なんでかなと思いつつ、エラーになる前の状態から1つずつ機能を追加していきました。