- 投稿日:2019-09-09T23:49:58+09:00

[SIGNATE練習問題]自動車の評価をやってみた#2 〜Metric Learningしてみた〜

前回の試しにXGBoostでやってみた記事から、距離学習を入れてみた。

※前回記事:[SIGNATE練習問題]自動車の評価をやってみた

Label EncodingとOne-hot Encodingの違い

前回はいきなりOne-hot Encodingで、カテゴリ変数化したが

Label Encodingによるカテゴリ変数化でも良いのでは?と思われたかもしれない。

という訳で、今回はまずLabel EncodingとOne-hot Encodingの2つを

検証してみる。ライブラリを読み込み

#ライブラリインポート import numpy as np import pandas as pd import pandas_profiling as pdpf import matplotlib.pyplot as plt from tqdm import tqdm_notebook import umap import metric_learn from scipy.sparse.csgraph import connected_components from xgboost import XGBRFClassifier from sklearn.model_selection import train_test_split from sklearn.preprocessing import LabelEncoderデータ読み込み

#train data train = pd.read_csv('./train.tsv',sep='\t') #test data test = pd.read_csv('./test.tsv', sep='\t')目的変数と説明変数に分離

#説明変数 train_df = train.drop(['id','class'], axis=1) #test用の説明変数 test_df = test.drop('id', axis=1) #目的変数 y = train['class'] #確認 print("train_df:",train_df.shape, "y:",y.shape, "test_df :",test_df.shape)TrainとTestを合体

# trainとtestでカテゴリーが異なるとダメだから、trainとtestをマージ length = train.shape[0] df = pd.concat([train_df, test_df], axis=0) print(df.columns)ようやく本題!

Label Encoding

df_le = pd.concat([train_df, test_df], axis=0) for i in list(df_le.columns): la_en = LabelEncoder() print(str(i)) la_en = la_en.fit(df_le[i]) la_en.fit(df_le[i]) df_le[i] = la_en.transform(df_le[i]) train_le = df_le.iloc[:length,:] test_le = df_le.iloc[length:,:] display(df_le)Label Encodingでは、それぞれ'0','1','2','3'などで、ただただカテゴリ変数化される。

buying maint doors persons lug_boot safety 0 1 2 2 0 2 1 1 1 0 2 2 2 2 2 3 0 0 0 2 2 3 0 0 2 2 0 2 4 0 0 2 0 1 0 ... ... ... ... ... ... ... 859 1 1 2 0 0 0 860 2 1 0 0 0 2 861 3 3 2 0 0 2 862 0 3 1 1 2 1 863 1 0 2 0 2 0 One-hot Encoding

一方、One-hot表現では、それぞれが[0,0,1],[0,1,0],[1,0,0]のように独立にラベル変数化されることがメリットである。

※ただのLabel Encodingでは、今回の'persons変数では

0:2人、1:4人、2:Moreとなるが、2人とMoreの平均が4人となってしまう。(ってことはMoreは6人??)この様な独立なラベルは、独立なまま特徴量にしたいからOne-hot Encodingを使う

df_oe = pd.concat([train_df, test_df], axis=0) df_dummy = pd.get_dummies(df_oe, prefix=df.columns) train_oe = df_dummy.iloc[:length,:] test_oe = df_dummy.iloc[length:,:] display(df_dummy)目的変数もラベル化

#LabelEncoderのインスタンスを生成 le = LabelEncoder() #ラベルを覚えさせる le = le.fit(["unacc", "acc", "good", "vgood"]) #ラベルを整数に変換 y_label = le.transform(y) y_label_i = le.inverse_transform(y_label)XGBoostで学習

X_train_le, X_test_le, y_train_le, y_test_le = train_test_split(train_le,y_label,test_size = .2,random_state = 666,stratify = y_label) X_train_oe, X_test_oe, y_train_oe, y_test_oe = train_test_split(train_oe,y_label,test_size = .2,random_state = 666,stratify = y_label) import xgboost as xgb from sklearn.metrics import accuracy_score #### Label Encoding #### dtrain = xgb.DMatrix(X_train_le, label=y_train_le, feature_names=X_train_le.columns) dvalid = xgb.DMatrix(X_test_le, label=y_test_le, feature_names=train_le.columns) dtest = xgb.DMatrix(test_le, feature_names=train_le.columns) xgb_params = { 'objective': 'multi:softmax', 'num_class': 4, 'eval_metric': 'mlogloss', } evals = [(dtrain, 'train'), (dvalid, 'eval')] evals_result = {} bst_le = xgb.train(xgb_params, dtrain, num_boost_round=100, early_stopping_rounds=10, evals=evals, evals_result=evals_result ) #### One-hot Encoding #### dtrain_oe = xgb.DMatrix(X_train_oe, label=y_train_oe, feature_names=X_train_oe.columns) dvalid_oe = xgb.DMatrix(X_test_oe, label=y_test_oe, feature_names=train_oe.columns) dtest_oe = xgb.DMatrix(test_oe, feature_names=train_oe.columns) xgb_params = { 'objective': 'multi:softmax', 'num_class': 4, 'eval_metric': 'mlogloss', } evals = [(dtrain_oe, 'train'), (dvalid_oe, 'eval')] evals_result = {} bst_oe = xgb.train(xgb_params, dtrain_oe, num_boost_round=100, early_stopping_rounds=10, evals=evals, evals_result=evals_result )結果

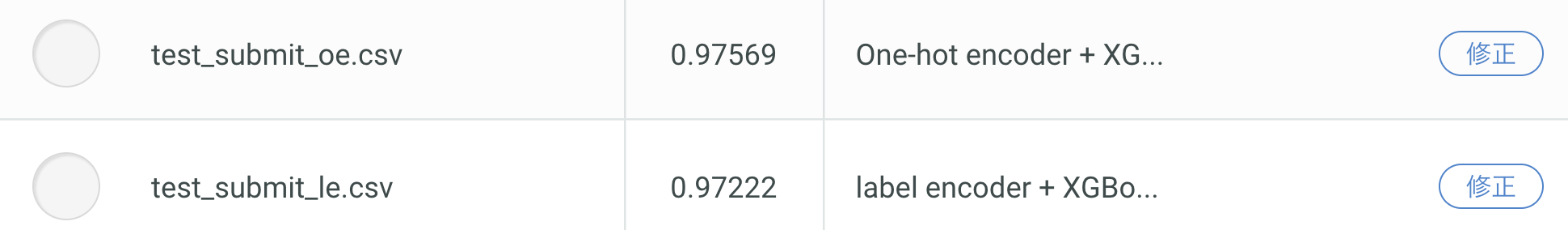

微々たる差だが、One-hotが優勢っぽい

特徴量増加のためMetric Learningをトライ

微妙な差で勝利したOne-hot版の説明変数を使用。

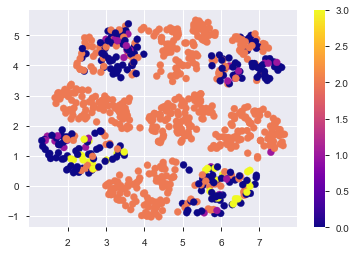

まずは、どんなデータになっているかを次元圧縮によって可視化(UMAPを使用)%time embedding = umap.UMAP().fit(train_oe) plt.scatter(embedding.embedding_[:,0], embedding.embedding_[:,1], c=y_label, cmap='plasma') plt.colorbar() plt.savefig('./fig/one-hot_umap.png', bbox_inches='tight') plt.show()今回は、この変数をscikit-learnのmetric learnを使って次元圧縮。

met_le = metric_learn.LMNN(k=5) met_le.fit(train_oe, y_label) %time X_met = met_le.transform(train_oe) %time X_met_test = met_le.transform(test_oe) %time met_embedding = umap.UMAP().fit(X_met) %time test_embedding = met_embedding.transform(X_met_test) plt.scatter(met_embedding.embedding_[:,0], met_embedding.embedding_[:,1], c=y_label, cmap='plasma') plt.colorbar() plt.savefig('./fig/metric_umap.png', bbox_inches='tight') plt.show()何もしない時よりも綺麗に分かれてる!気がする。

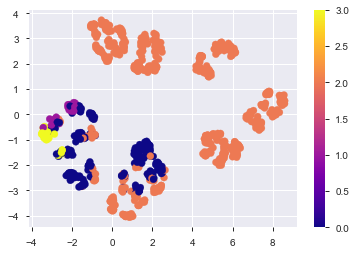

この分布上にTest用のデータを並べてみる。plt.scatter(met_embedding.embedding_[:,0], met_embedding.embedding_[:,1], c=y_label, cmap='plasma', label='train') plt.colorbar() plt.scatter(test_embedding[:,0], test_embedding[:,1], c='gold', edgecolor='black', linewidth=.7, marker='*', s=50, label='test') plt.legend() plt.savefig('./fig/metric_test_on.png', bbox_inches='tight') plt.show()これだけでもなんとなく分離できそう...??

座標位置と距離を新たな特徴量として追加

元々のOne-hot encodingの説明変数に、今回作ってみた特徴量を追加。

X_met_df = pd.DataFrame(X_met, columns=np.arange(0,21,1).astype(str)) X_met_test_df = pd.DataFrame(X_met_test, columns=np.arange(0,21,1).astype(str)) embe = pd.DataFrame(met_embedding.embedding_, columns=['locate_x', 'locate_y']) test_embe = pd.DataFrame(test_embedding, columns=['locate_x', 'locate_y']) met_oe = pd.concat([train_oe, X_met_df], axis=1) met_oe = pd.concat([met_oe, embe], axis=1) met_test_oe = pd.concat([test_oe, X_met_test_df], axis=1) met_test_oe = pd.concat([met_test_oe, test_embe], axis=1) print(met_oe.shape, met_test_oe.shape) # (864, 44) (864, 44)再度XGBoostで学習

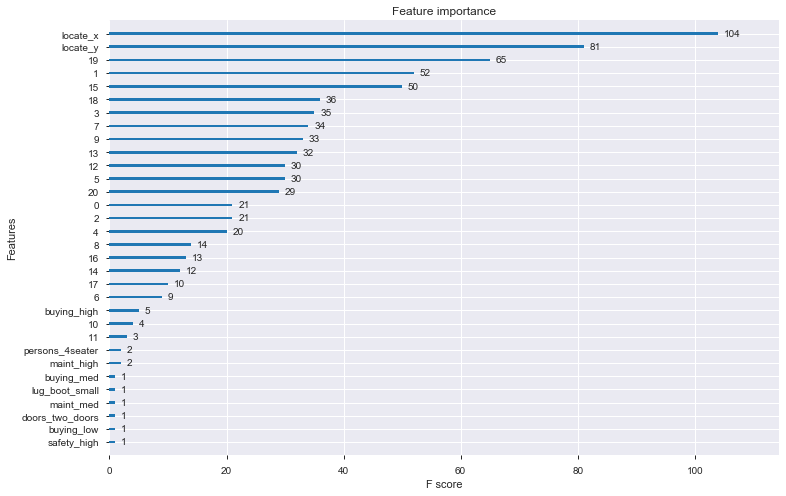

X_train_me, X_test_me, y_train_me, y_test_me = train_test_split(met_oe, y_label, test_size = .2, random_state = 666, stratify = y_label) dtrain_me = xgb.DMatrix(X_train_me, label=y_train_me, feature_names=X_train_me.columns) dvalid_me = xgb.DMatrix(X_test_me, label=y_test_me, feature_names=X_train_me.columns) dtest_me = xgb.DMatrix(met_test_oe, feature_names=met_test_oe.columns) xgb_params = { 'objective': 'multi:softmax', 'num_class': 4, 'eval_metric': 'mlogloss', } evals = [(dtrain_me, 'train'), (dvalid_me, 'eval')] evals_result = {} bst_me = xgb.train(xgb_params, dtrain_me, num_boost_round=100, early_stopping_rounds=10, evals=evals, evals_result=evals_result )ちなみに、特徴量寄与度はこんな感じ

_, ax = plt.subplots(figsize=(12, 8)) xgb.plot_importance(bst_me, ax=ax, importance_type='weight', show_values=True) plt.show()座標位置が効いていそう...

結果出力

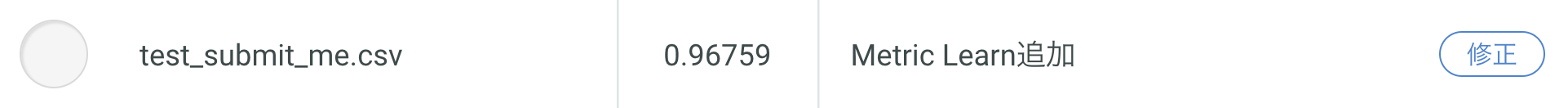

y_pred_me = bst_me.predict(dtest_me) y_pred_me = y_pred_me.astype(np.int) y_pred_me_i = le.inverse_transform(y_pred_me) submit_me = pd.read_csv('./sample_submit.csv', sep=',',header=None) submit_me.loc[:,1] = y_pred_me_i submit_me.to_csv("test_submit_me.csv", index = None, header = None)あれ!!!なんか精度下がっている!!

過学習しているのか!?もう少し真面目に特徴量を増やすのと、過学習防止に5-foldでの検証など

まだまだやる余地はたくさんありそう。でもMetric Learningによる特徴量生成はうまくいく可能性がありそう。

to be continued.

- 投稿日:2019-09-09T23:23:05+09:00

Raspberry Pi ZERO WH + ACM1602NI LCD液晶 + BME280温湿度気圧センサーで色々表示してみる

ラズパイに液晶をくっつけて色々表示したら面白いんじゃないかと唐突に思いついたので作ってみました。

※最終的には魔改造の結果、ラズパイ起動後に自動実行され日付、時刻、温度、湿度、CPU使用率、メモリー使用率、IPアドレスが表示されるようになりました。

※pythonプログラミングは超初心者です。美しいコードとか一切意識してません。また作りたいから作っただけで実用性は無視です。基本的には自分用の覚書です。用意したもの

Raspberry Pi ZERO WH

http://akizukidenshi.com/catalog/g/gM-12958/

LCD液晶 ACM1602NI

http://akizukidenshi.com/catalog/g/gP-05693/

100kΩ半固定抵抗(↑のLCDを使うならこれが必要)

http://akizukidenshi.com/catalog/g/gP-08014/

温湿度気圧センサー BME280

http://akizukidenshi.com/catalog/g/gK-09421/

その他、ハンダゴテ、ブレッドボード、ラズパイ接続環境などの電子工作及びRaspberry Pi関連一般機器①I2C接続を有効にしてLCDに文字を出してみる

ラズパイではデフォルトではI2C接続が無効になっているはずです。

設定を行いI2Cを有効化、サンプルプログラムを使いなにか文字を投影しLCDの動作確認まで行います。

ポイントは、dtparam=i2c_baudrate=50000を設定すること、i2cdetectをしないことです。

私の場合はボーレートを設定するconfig.txt内でi2cに関する設定文のコメントアウトをはずしてやらないと動きませんでした。

その後https://github.com/yuma-m/raspi_lcd_acm1602ni.gitのサンプルプログラムで文字が表示されればOK

詳細な説明は参考ページをがわかりやすいです。↓

https://www.denshi.club/pc/raspi/i2caqmlcdarduinode1-aqm0802-2.html

http://yura2.hateblo.jp/entry/2016/02/13/Raspberry_Pi%E3%81%AB%E6%8E%A5%E7%B6%9A%E3%81%97%E3%81%9FLCD%28ACM1602NI%29%E3%82%92Python%E3%81%A7%E5%8B%95%E3%81%8B%E3%81%99

https://ameblo.jp/raspberrypi-iot/entry-12345308004.html②BME280を接続して温度、湿度、気圧を取得してみる

次にBME280センサーを接続してデータの取得をしてみます。

先にLCD液晶の回路があるはずなのでそこに追加する形でいきました。

I2C接続は線を共用できるので配線が少なく楽ですね。

配線後にhttps://github.com/SWITCHSCIENCE/BME280/blob/master/Python27/bme280_sample.pyのサンプルプログラムを使って各種データが取得できればOK

ポイントは、今回のようにACM1602NIをすでに接続した状態でテストをするならやっぱりi2cdetectはやってはいけません。

これをやると液晶が止まります・・・

詳細な説明は参考ページをがわかりやすいです。↓

https://deviceplus.jp/hobby/raspberrypi_entry_039/③BME280のデータをLCDに投影する

LCD表示のサンプルプログラムを見るとmain関数の中は次のようになっていました。

raspi_lcd.py(前略) def main(): if not 2 <= len(sys.argv) <= 3: print('Usage: python raspi_lcd.py "message for line 1" ["message for line 2"]') return else: lcd_controller = LCDController() lcd_controller.display_messages(sys.argv[1:3]) (後略)ここでコマンドラインから引数としてうけとった文字列の数を判定し、受け取った引数が1または2ならlcd_controller.display_messages(sys.argv[1:3])に渡してLCDに投影されるようです。

※ちなみに引数はsys.argvに格納されますがsys.argv[0]はプログラム名が入るらしいです。

・・・適当にリストを作ってそこに文字列を格納しlcd_controller.display_messagesに渡せば投影できるのでは?(単純

というわけでBME280のサンプルプログラムをLCD表示サンプルプログラムに無理やり追記しLCD表示に関するmain関数部分のみ次のように書き換えました

var_h,temperature,pressurear_h,temperature,pressureの各変数をグローバル変数化し参照できるように変えているので注意

また、このLCDは仕様上「℃」の文字が使えません。BME280のサンプルプログラムをそのまま使うと「℃」が表示できずエラーを起こしますのでなにかしら対策が必要です。私は代わりに「’C」を表示するようにしました。lcd.py(前略) def main(): while 1: lcddisp = [] #LCD表示文字列格納リスト readData() #BME280のデータ取得関数 lcdhum = ("HUM:%6.2f %" % (var_h)) #取得した湿度に表示用の文字列を追加 lcdtemp = ("TEMP: %-6.2f'C" % (temperature)) #取得した気温に表示用の文字列を追加 lcdpressure = ("pressure:%7.2fhPa" % (pressure/100)) #取得した気圧に表示用の文字列を追加 lcddisp.append(lcdtemp) #LCD表示文字列格納リストに気温を追加 lcddisp.append(lcdhum) #LCD表示文字列格納リストに湿度を追加 lcd_controller = LCDController() lcd_controller.display_messages(lcddisp[0:2]) #LCD表示文字列格納リストを表示関数に渡す time.sleep(2) #2秒待機後にLCD表示アップデート (後略)④日付と時刻を表示する

せっかくなので日付と時刻ぐらい表示したくね?(いきあたりばったりの思いつき)

main関数が以下のようになりました。(import datetime忘れないでね)lcd.py(前略) import datetime (中略) def main(): while 1: lcddisp = [] #LCD表示文字列格納リスト readData() #BME280のデータ取得関数 lcdhum = ("HUM:%6.2f %" % (var_h)) #取得した湿度に表示用の文字列を追加 lcdtemp = ("TEMP: %-6.2f'C" % (temperature)) #取得した気温に表示用の文字列を追加 lcdpressure = ("pressure:%7.2fhPa" % (pressure/100)) #取得した気圧に表示用の文字列を追加 lcddisp.append(lcdtemp) #LCD表示文字列格納リストに気温を追加 lcddisp.append(lcdhum) #LCD表示文字列格納リストに湿度を追加 lcd_controller = LCDController() lcd_controller.display_messages(lcddisp[0:2]) #LCD表示文字列格納リストを表示関数に渡す time.sleep(2) #2秒待機後にLCD表示アップデート lcddisp = [] #LCD表示文字列格納リストリセット dt_now = datetime.datetime.now() #現在時刻の取得 lcddisp.append(dt_now.strftime('DATE: %Y/%m/%d')) #年月日を格納 lcddisp.append(dt_now.strftime('TIME: %H:%M:%S')) #時分秒を格納 lcd_controller = LCDController() lcd_controller.display_messages(lcddisp[0:2]) #LCD表示文字列格納リストを表示関数に渡す time.sleep(2) #2秒待機後にLCD表示アップデート (後略)⑤CPU使用率とメモリー使用率を表示する

将来のヘッドレス運用に備えてCPU使用率とメモリー使用率も監視したいよね?

どうやらpsutilモジュールなるものを使うとできるらしい

参考↓

https://algorithm.joho.info/programming/python/psutil-cpu-memory-usage/

そして度重なるmain関数の魔改造lcd.py(前略) import psutil (中略) def main(): while 1: lcddisp = [] #LCD表示文字列格納リスト readData() #BME280のデータ取得関数 lcdhum = ("HUM:%6.2f %" % (var_h)) #取得した湿度に表示用の文字列を追加 lcdtemp = ("TEMP: %-6.2f'C" % (temperature)) #取得した気温に表示用の文字列を追加 lcdpressure = ("pressure:%7.2fhPa" % (pressure/100)) #取得した気圧に表示用の文字列を追加 lcddisp.append(lcdtemp) #LCD表示文字列格納リストに気温を追加 lcddisp.append(lcdhum) #LCD表示文字列格納リストに湿度を追加 lcd_controller = LCDController() lcd_controller.display_messages(lcddisp[0:2]) #LCD表示文字列格納リストを表示関数に渡す time.sleep(2) #2秒待機後にLCD表示アップデート lcddisp = [] #LCD表示文字列格納リストリセット dt_now = datetime.datetime.now() #現在時刻の取得 lcddisp.append(dt_now.strftime('DATE: %Y/%m/%d')) #年月日を格納 lcddisp.append(dt_now.strftime('TIME: %H:%M:%S')) #時分秒を格納 lcd_controller = LCDController() lcd_controller.display_messages(lcddisp[0:2]) #LCD表示文字列格納リストを表示関数に渡す time.sleep(2) #2秒待機後にLCD表示アップデート lcddisp = [] #LCD表示文字列格納リストリセット memory = psutil.virtual_memory() #メモリー使用率取得 cpu_percent = psutil.cpu_percent(interval=1) #CPU使用率取得 lcdmem = ('MEM: ' + str(memory.percent) + " %") #メモリ使用率に表示用の文字列を追加 lcdcpu = ('CPU: ' + str(cpu_percent) + " %") #CPU使用率に表示用の文字列を追加 lcddisp.append(lcdcpu) #CPU使用率を格納 lcddisp.append(lcdmem) #メモリー使用率を格納 lcd_controller = LCDController() lcd_controller.display_messages(lcddisp[0:2]) #LCD表示文字列格納リストを表示関数に渡す time.sleep(2) #2秒待機後にLCD表示アップデート (後略)⑥IPアドレスを表示する

ラズパイ起動後にIPアドレス表示してくれたらSSHとかRDPとかするとき便利だよね、と思いついたので・・・

どうやらgethostnameを使うとできるとあるが127.0.0.1しか取得できない・・・

調べると以下のページに答えがあったので参考に↓

https://qiita.com/kjunichi/items/8e4967d04c3a1f6af35e

そしてmain関数を含めた最終的なコードの全容は次の通りlcd.py#!/usr/bin/env python # -*- coding: utf-8 -*- from __future__ import print_function from smbus2 import SMBus import sys import time import smbus import unicodedata import datetime import psutil import socket from config import BUS_NUMBER, LCD_ADDR, SLEEP_TIME, DELAY_TIME from character_table import INITIALIZE_CODES, LINEBREAK_CODE, CHAR_TABLE COMMAND_ADDR = 0x00 DATA_ADDR = 0x80 bus_number = 1 i2c_address = 0x76 bus = SMBus(bus_number) digT = [] digP = [] digH = [] t_fine = 0.0 pressure = 0.0 temperature = 0.0 var_h = 0.0 lcddisp = ["0","0"] def writeReg(reg_address, data): bus.write_byte_data(i2c_address,reg_address,data) def get_calib_param(): calib = [] for i in range (0x88,0x88+24): calib.append(bus.read_byte_data(i2c_address,i)) calib.append(bus.read_byte_data(i2c_address,0xA1)) for i in range (0xE1,0xE1+7): calib.append(bus.read_byte_data(i2c_address,i)) digT.append((calib[1] << 8) | calib[0]) digT.append((calib[3] << 8) | calib[2]) digT.append((calib[5] << 8) | calib[4]) digP.append((calib[7] << 8) | calib[6]) digP.append((calib[9] << 8) | calib[8]) digP.append((calib[11]<< 8) | calib[10]) digP.append((calib[13]<< 8) | calib[12]) digP.append((calib[15]<< 8) | calib[14]) digP.append((calib[17]<< 8) | calib[16]) digP.append((calib[19]<< 8) | calib[18]) digP.append((calib[21]<< 8) | calib[20]) digP.append((calib[23]<< 8) | calib[22]) digH.append( calib[24] ) digH.append((calib[26]<< 8) | calib[25]) digH.append( calib[27] ) digH.append((calib[28]<< 4) | (0x0F & calib[29])) digH.append((calib[30]<< 4) | ((calib[29] >> 4) & 0x0F)) digH.append( calib[31] ) for i in range(1,2): if digT[i] & 0x8000: digT[i] = (-digT[i] ^ 0xFFFF) + 1 for i in range(1,8): if digP[i] & 0x8000: digP[i] = (-digP[i] ^ 0xFFFF) + 1 for i in range(0,6): if digH[i] & 0x8000: digH[i] = (-digH[i] ^ 0xFFFF) + 1 def readData(): data = [] for i in range (0xF7, 0xF7+8): data.append(bus.read_byte_data(i2c_address,i)) pres_raw = (data[0] << 12) | (data[1] << 4) | (data[2] >> 4) temp_raw = (data[3] << 12) | (data[4] << 4) | (data[5] >> 4) hum_raw = (data[6] << 8) | data[7] compensate_T(temp_raw) compensate_P(pres_raw) compensate_H(hum_raw) def compensate_P(adc_P): global t_fine global pressure v1 = (t_fine / 2.0) - 64000.0 v2 = (((v1 / 4.0) * (v1 / 4.0)) / 2048) * digP[5] v2 = v2 + ((v1 * digP[4]) * 2.0) v2 = (v2 / 4.0) + (digP[3] * 65536.0) v1 = (((digP[2] * (((v1 / 4.0) * (v1 / 4.0)) / 8192)) / 8) + ((digP[1] * v1) / 2.0)) / 262144 v1 = ((32768 + v1) * digP[0]) / 32768 if v1 == 0: return 0 pressure = ((1048576 - adc_P) - (v2 / 4096)) * 3125 if pressure < 0x80000000: pressure = (pressure * 2.0) / v1 else: pressure = (pressure / v1) * 2 v1 = (digP[8] * (((pressure / 8.0) * (pressure / 8.0)) / 8192.0)) / 4096 v2 = ((pressure / 4.0) * digP[7]) / 8192.0 pressure = pressure + ((v1 + v2 + digP[6]) / 16.0) def compensate_T(adc_T): global t_fine global temperature v1 = (adc_T / 16384.0 - digT[0] / 1024.0) * digT[1] v2 = (adc_T / 131072.0 - digT[0] / 8192.0) * (adc_T / 131072.0 - digT[0] / 8192.0) * digT[2] t_fine = v1 + v2 temperature = t_fine / 5120.0 def compensate_H(adc_H): global t_fine global var_h var_h = t_fine - 76800.0 if var_h != 0: var_h = (adc_H - (digH[3] * 64.0 + digH[4]/16384.0 * var_h)) * (digH[1] / 65536.0 * (1.0 + digH[5] / 67108864.0 * var_h * (1.0 + digH[2] / 67108864.0 * var_h))) else: return 0 var_h = var_h * (1.0 - digH[0] * var_h / 524288.0) if var_h > 100.0: var_h = 100.0 elif var_h < 0.0: var_h = 0.0 def setup(): osrs_t = 1 #Temperature oversampling x 1 osrs_p = 1 #Pressure oversampling x 1 osrs_h = 1 #Humidity oversampling x 1 mode = 3 #Normal mode t_sb = 5 #Tstandby 1000ms filter = 0 #Filter off spi3w_en = 0 #3-wire SPI Disable ctrl_meas_reg = (osrs_t << 5) | (osrs_p << 2) | mode config_reg = (t_sb << 5) | (filter << 2) | spi3w_en ctrl_hum_reg = osrs_h writeReg(0xF2,ctrl_hum_reg) writeReg(0xF4,ctrl_meas_reg) writeReg(0xF5,config_reg) setup() get_calib_param() class LCDController: def __init__(self): self.bus = smbus.SMBus(BUS_NUMBER) pass def send_command(self, command, is_data=True): if is_data: self.bus.write_i2c_block_data(LCD_ADDR, DATA_ADDR, [command]) else: self.bus.write_i2c_block_data(LCD_ADDR, COMMAND_ADDR, [command]) time.sleep(DELAY_TIME) def initialize_display(self): for code in INITIALIZE_CODES: self.send_command(code, is_data=False) def send_linebreak(self): for code in LINEBREAK_CODE: self.send_command(code, is_data=False) def normalize_message(self, message): if isinstance(message, str): message = message.decode('utf-8') return unicodedata.normalize('NFKC', message) def convert_message(self, message): char_code_list = [] for char in message: if char not in CHAR_TABLE: error_message = 'undefined character: %s' % (char.encode('utf-8')) raise ValueError(error_message) char_code_list += CHAR_TABLE[char] if len(char_code_list) > 16: raise ValueError('Exceeds maximum length of characters for each line: 16') return char_code_list def display_one_line(self, line_no, message): message = self.normalize_message(message) char_code_list = self.convert_message(message) for code in char_code_list: self.send_command(code) def display_messages(self, message_list): self.initialize_display() time.sleep(SLEEP_TIME) for line_no, message in enumerate(message_list): if line_no == 1: self.send_linebreak() self.display_one_line(line_no, message) def main(): while 1: lcddisp = [] s = socket.socket(socket.AF_INET, socket.SOCK_DGRAM) s.connect(("8.8.8.8",80)) ip = s.getsockname()[0] lcddisp.append("IP address:") lcddisp.append(ip) lcd_controller = LCDController() lcd_controller.display_messages(lcddisp[0:2]) time.sleep(2) lcddisp = [] dt_now = datetime.datetime.now() lcddisp.append(dt_now.strftime('DATE: %Y/%m/%d')) lcddisp.append(dt_now.strftime('TIME: %H:%M:%S')) lcd_controller = LCDController() lcd_controller.display_messages(lcddisp[0:2]) time.sleep(2) lcddisp = [] readData() lcdhum = ("HUM:%6.2f %" % (var_h)) lcdtemp = ("TEMP: %-6.2f'C" % (temperature)) lcdpressure = ("pressure:%7.2fhPa" % (pressure/100)) lcddisp.append(lcdtemp) lcddisp.append(lcdhum) lcd_controller = LCDController() lcd_controller.display_messages(lcddisp[0:2]) time.sleep(2) lcddisp = [] memory = psutil.virtual_memory() cpu_percent = psutil.cpu_percent(interval=1) lcdmem = ('MEM: ' + str(memory.percent) + " %") lcdcpu = ('CPU: ' + str(cpu_percent) + " %") lcddisp.append(lcdcpu) lcddisp.append(lcdmem) lcd_controller = LCDController() lcd_controller.display_messages(lcddisp[0:2]) time.sleep(2) if __name__ == '__main__': main()クソコード臭が拭えませんが普通に動くので気にしません。

⑦ラズパイ起動後に自動起動させる

ヘッドレス運用時にラズパイ起動後に自動で起動してくれればIPアドレスとかとれるし正常起動したかわかるし便利そうなので設定してみました。

どうやらsystemdを設定すればいけるそうなので参考ページのとおりに設定したらあっさりいけました。

参考↓

https://qiita.com/molchiro/items/ee32a11b81fa1dc2fd8d

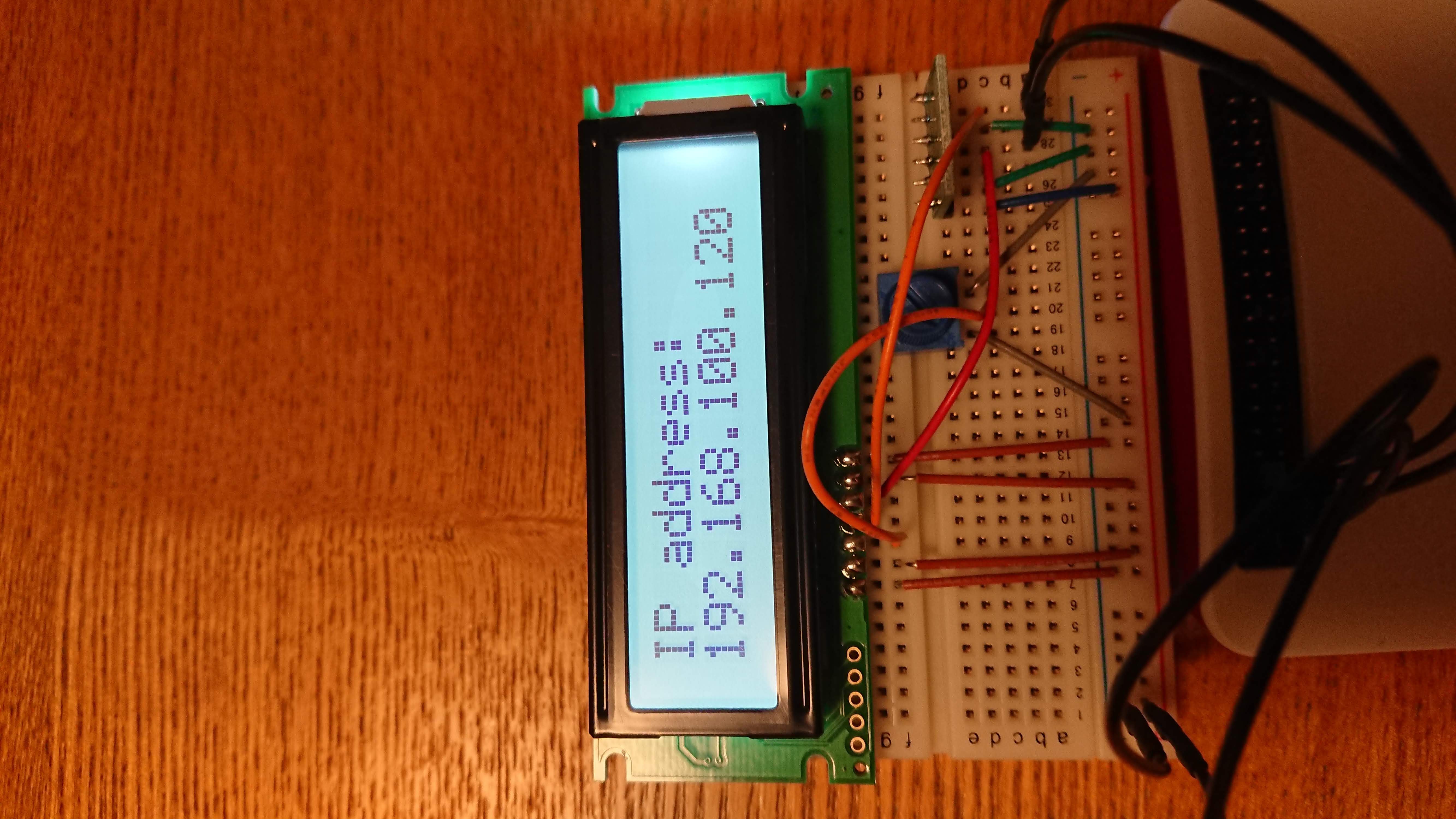

https://qiita.com/ikemura23/items/6f9adce99a3db555a0e4⑧動作の様子

こんな感じで動いてます

最終的にラズパイ起動時に自動実行されて日付、時刻、温度、湿度、cpu使用率、メモリー使用率、ipアドレスが自動表示される謎表示機になりました。

— しょうとくた (@syotokuta) September 9, 2019

ipアドレスやcpu使用率はヘッドレス運用時に便利かな pic.twitter.com/qAPwQ4F8pQ

- 投稿日:2019-09-09T23:00:14+09:00

Amazon Linux2 に Python3.7.4をインストール

最初からインストールされているのは3.6系だったので。

$ sudo yum install gcc openssl-devel bzip2-devel $ cd /usr/src $ sudo wget https://www.python.org/ftp/python/3.7.4/Python-3.7.4.tgz $ sudo tar xzf Python-3.7.4.tgz $ cd Python-3.7.4 $ sudo ./configure --enable-optimizations $ sudo make altinstall $ sudo rm /usr/src/Python-3.7.4.tgz $ python3.7 -V Python 3.7.4 $ vi /home/ec2-user/.bashrc # User specific aliases and functions alias python=python3.7 $ python -V Python 3.7.4

- 投稿日:2019-09-09T22:49:16+09:00

【Python】AWS Lambda + DynamoDBでTodoリスト用REST APIを構築した際にハマったこと

はじめに

AWS Lambda + DynamoDBでTodoリスト用REST APIを構築した際にハマったことのメモ。

構築したもの:https://github.com/r-wakatsuki/kadai4todo

ハマったこと

以下、ハマった際に遭遇した事象と解決方法を記載していく。

DynamoDBをまともに利用したのが初めてだったため、DynamoDBについてがほとんどである。1. DynamoDBに登録するデータの値には空文字は指定できないがnullは登録可能。ただしその場合は同じプロパティにNULL型とその他の型が混在することになる。

事象

contentプロパティに空文字が指定されている場合、空文字をString型のままDynamoDBに登録しようとすると、ClientError: An error occurred (ValidationException) when calling the PutItem operation: One or more parameter values were invalid: An AttributeValue may not contain an empty stringというエラーとなる。InputEvent: { "httpMethod": "POST", "resource": "/todo", "body": "{\"title\": \"たいとるですよ\",\"content\": \"\"}" } API:<Todo登録> #〜中略〜 #要素定義:content req_content = req_body_dict.get('content','') if req_content == None: req_content = '' #〜中略〜 #<Todo登録>実行 item = { "todoid": str(uuid.uuid4()), "title": req_title, "content": req_content, "priority": req_priority, "done": req_done, "created_at": current_date, "updated_at": current_date } table.put_item( Item = item ) #<Todo登録>実行結果リターン return(return200(item)) Response: { "errorMessage": "An error occurred (ValidationException) when calling the PutItem operation: One or more parameter values were invalid: An AttributeValue may not contain an empty string", "errorType": "ClientError", "stackTrace": [ " File \"/var/task/lambda_function.py\", line 72, in lambda_handler\n Item = item\n", " File \"/var/runtime/boto3/resources/factory.py\", line 520, in do_action\n response = action(self, *args, **kwargs)\n", " File \"/var/runtime/boto3/resources/action.py\", line 83, in __call__\n response = getattr(parent.meta.client, operation_name)(**params)\n", " File \"/var/runtime/botocore/client.py\", line 320, in _api_call\n return self._make_api_call(operation_name, kwargs)\n", " File \"/var/runtime/botocore/client.py\", line 623, in _make_api_call\n raise error_class(parsed_response, operation_name)\n" ] }

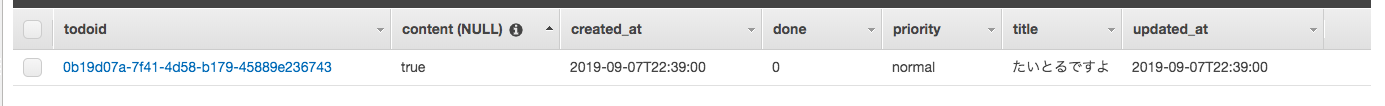

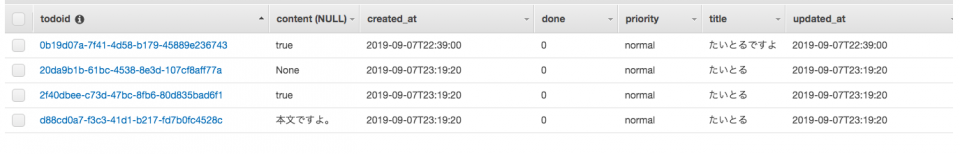

contentプロパティが空文字の場合にNULL型に変換する処理を入れ、NULL型でDynamoDBへの登録を試みると、登録処理は問題なく行われる。InputEvent: { "httpMethod": "POST", "resource": "/todo", "body": "{\"title\": \"たいとるですよ\",\"content\": \"\"}" } API:<Todo登録> #〜中略〜 #要素定義:content req_content = req_body_dict.get('content') if req_content == '':#空文字の場合はnull型を入れるようにする。 req_content = None #〜中略〜 #<Todo登録>実行 item = { "todoid": str(uuid.uuid4()), "title": req_title, "content": req_content, "priority": req_priority, "done": req_done, "created_at": current_date, "updated_at": current_date } table.put_item( Item = item ) #<Todo登録>実行結果リターン return(return200(item)) Response: { "statusCode": 200, "body": { "todoid": "0b19d07a-7f41-4d58-b179-45889e236743", "title": "たいとるですよ", "content": null, "priority": "normal", "done": 0, "created_at": "2019-09-07T22:39:00", "updated_at": "2019-09-07T22:39:00" } }しかし、DynamoDBのコンソール画面からテーブルを見ると登録したデータの

contentプロパティの値がtrueとなっている。

さらにDynamoDBのテーブルにデータが一つも登録されていない状態であったため、contentプロパティの型がNULL型となっている。この状態で

contentプロパティにいくつか値を指定して登録し、取得してみると次のような結果となった。

ユーザーが登録しようとする値(型) DynamoDBに登録する際の値(型) DynamoDB管理画面上の値 実際にDynamoDBに登録された値(型) (String) null(NULL) true null(NULL) true(String) true(String) true true(String) 本文ですよ。(String) 本文ですよ。(String) 本文ですよ。 本文ですよ。(String) None(String) None(String) None None(String) 要するに登録時のデータの型をDynamoDB側で保持してくれている動作となる。これでも運用できなくはないがString型とNULL型が同じプロパティに混在しているのは気持ち悪い。

解決

Todoデータの登録時や更新時に

contentプロパティの末尾に</end>タグを必ず付与して、String型のみを扱うようにした。API:<Todo登録> #〜中略〜 #要素定義:content req_content = req_body_dict.get('content') if req_content == None: req_content = '</end>' else: req_content = req_content + '</end>' #〜中略〜 #<Todo登録>実行 item = { "todoid": str(uuid.uuid4()), "title": req_title, "content": req_content, "priority": req_priority, "done": int(req_done), #明示的にint型に設定 "created_at": current_date, "updated_at": current_date } table.put_item( Item = item )Todoデータの取得時には

content属性の末尾から</end>タグを除去する処理を入れた。import re API:<Todo個別取得> ##DBからTodoをtodoidで取得 todo = table.get_item( Key={ 'todoid': req_todoid } )['Item'] #contentから</end>タグ削除 todo['content'] = re.sub('</end>$', '', todo['content'])2. DynamoDBにint型で登録した値が取り出し時にDecimal型になる

事象

Todoステータス

doneプロパティの値は「未完了0」と「完了1」の2パターンとしている。

そこでDynamoDBへのTodo登録時の処理ではTodoのdoneプロパティの値を明示的にint型に設定してDynamoDBに登録するようにした。InputEvent: { "httpMethod": "POST", "resource": "/todo", "body": "{\"title\": \"内部定例\",\"done\": 0}" } API:<Todo登録> #〜中略〜 #<Todo登録>実行 item = { "todoid": str(uuid.uuid4()), "title": req_title, "content": req_content, "priority": req_priority, "done": int(req_done), #明示的にint型に設定 "created_at": current_date, "updated_at": current_date } table.put_item( Item = item ) Response: { "todoid": "35f047ba-1121-4473-8587-b893f0938389", "title": "内部定例", "content": "", "priority": "normal", "done": 0, "created_at": "2019-09-07T16:27:54", "updated_at": "2019-09-07T16:27:54" }しかし、登録したデータをDynamoDBから取得すると

doneプロパティの値がDecimal型<class 'decimal.Decimal'>となってしまっている。

また、取得したデータをレスポンスするためにjson.dumpsしようとするとTypeError:Object of type Decimal is not JSON serializableとなりJSONシリアライズできない。InputEvent: { "httpMethod": "GET", "resource": "/todo/{todoid}", "pathParameters": "{\"todoid\": \"35f047ba-1121-4473-8587-b893f0938389\"}" } API:<Todo個別取得> #〜中略〜 ##DBからTodoをtodoidで取得 todo = table.get_item( Key={ 'todoid': req_todoid } )['Item'] print(type(todo['done']))#型確認 #〜中略〜 #<Todo個別取得>実行結果リターン return{ 'statusCode': 200, 'body': json.dumps(todo) } Fanction Logs: <class 'decimal.Decimal'> Response: { "errorMessage": "Object of type Decimal is not JSON serializable", "errorType": "TypeError", "stackTrace": [ " File \"/var/task/lambda_function.py\", line 209, in lambda_handler\n 'body': json.dumps(item)\n", " File \"/var/lang/lib/python3.7/json/__init__.py\", line 231, in dumps\n return _default_encoder.encode(obj)\n", " File \"/var/lang/lib/python3.7/json/encoder.py\", line 199, in encode\n chunks = self.iterencode(o, _one_shot=True)\n", " File \"/var/lang/lib/python3.7/json/encoder.py\", line 257, in iterencode\n return _iterencode(o, 0)\n", " File \"/var/lang/lib/python3.7/json/encoder.py\", line 179, in default\n raise TypeError(f'Object of type {o.__class__.__name__} '\n" ] }解決

json.dumps時にDecimal型の値があればint型に変換するようにした。InputEvent: { "httpMethod": "GET", "resource": "/todo/{todoid}", "pathParameters": "{\"todoid\": \"35f047ba-1121-4473-8587-b893f0938389\"}" } API:<Todo個別取得> ##DBからTodoをtodoidで取得 todo = table.get_item( Key={ 'todoid': req_todoid } )['Item'] #〜中略〜 #Decimal型の場合はint型に変換 def decimal_default_proc(obj): if isinstance(obj, Decimal): return int(obj) raise TypeError #<Todo個別取得>実行結果リターン return{ 'statusCode': 200, 'body': json.dumps(todo,default=decimal_default_proc) } Response: { "todoid": "35f047ba-1121-4473-8587-b893f0938389", "title": "内部定例", "content": "", "priority": "normal", "done": 0, "created_at": "2019-09-07T16:27:54", "updated_at": "2019-09-07T16:27:54" }上記ではDecimal -> int変換用の関数を利用しているが、関数を使わなくてもDecimal型になることが事前に分かっている値は個別に

int(値)すればよい。参考

https://qiita.com/ekzemplaro/items/5fa8900212252ab554a3

https://docs.aws.amazon.com/ja_jp/amazondynamodb/latest/developerguide/GettingStarted.Python.03.html3.DynamoDBに登録されるデータのプロパティの並び順を定義できない。

事象

例えば、以下のようにプロパティの順番を整列させたTodoをDynamoDBに登録する。

API:<Todo登録> #〜中略〜 #<Todo登録>実行 item = { "todoid": str(uuid.uuid4()), "title": req_title, "content": req_content, "priority": req_priority, "done": req_done, "created_at": current_date, "updated_at": current_date } table.put_item( Item = item )登録したデータをDynamoDBから取得するとプロパティの並び順が整列されていない。

API:<Todo個別取得> ##DBからTodoをtodoidで取得 todo = table.get_item( Key={ 'todoid': req_todoid } )['Item'] #〜中略〜 #<Todo個別取得>実行結果リターン return{ 'statusCode': 200, 'body': json.dumps(todo) } Response: { "updated_at": "2019-09-01T21:38:37", "content": "定期券の更新ができた", "todoid": "6f9cd0e6-fbf0-48be-ac64-b4763c482d4d", "created_at": "2019-09-01T20:32:30", "priority": "normal", "done": 1, "title": "定期更新" }DynamoDB自体の設定でもプロパティの並び順をあらかじめ定義する設定は見当たらない。

解決

取得後にプロパティの並び順を整列する処理を入れる。

API:<Todo個別取得> ##DBからTodoをtodoidで取得 todo = table.get_item( Key={ 'todoid': req_todoid } )['Item'] #〜中略〜 #プロパティ並び順整列 item = { "todoid": todo['todoid'], "title": todo['title'], "content": todo['content'], "priority": todo['priority'], "done": todo['done'], "created_at": todo['created_at'], "updated_at": todo['updated_at'] } #<Todo個別取得>実行結果リターン return{ 'statusCode': 200, 'body': json.dumps(item) } Response: { "todoid": "6f9cd0e6-fbf0-48be-ac64-b4763c482d4d", "title": "定期更新", "content": "定期券の更新ができた", "priority": "normal", "done": 1, "created_at": "2019-09-01T20:32:30", "updated_at": "2019-09-01T21:38:37" }以上

- 投稿日:2019-09-09T22:35:01+09:00

乃木坂46起点のアーティスト関係図を描画する(Spotify API, Network X)

はじめに

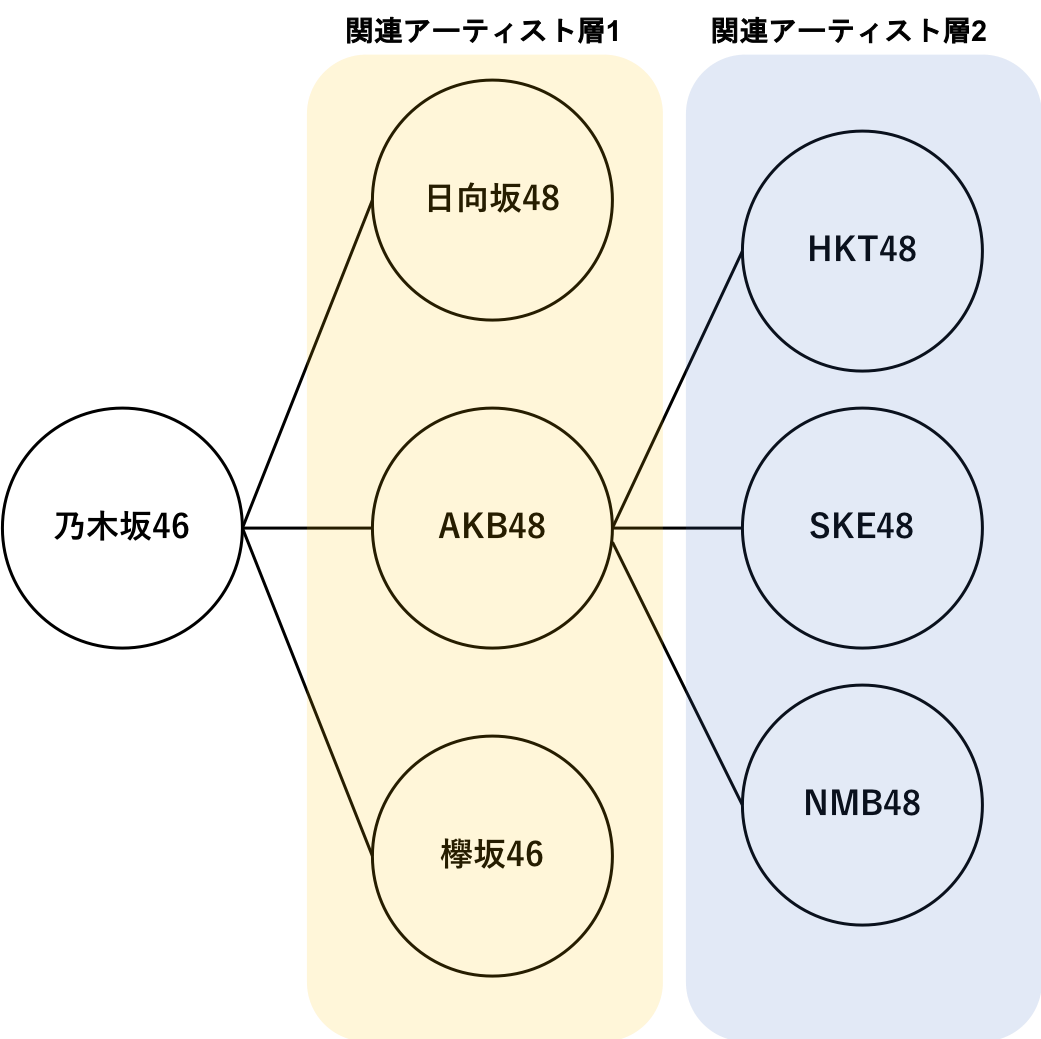

Spotify APIで乃木坂46の関連アーティストを呼び出し、PythonライブラリのNetwork Xを使って、アーティスト関係図を描画したいと思います。

Spotify APIの利用方法や基本的な機能はこちら(Spotify APIで乃木坂46を分析したい)に投稿しています。参考

Spotify APIで好きなアーティストの繋がりを可視化してディグる

https://blog.aidemy.net/entry/2018/08/31/142408Spotipyのドキュメント(spotipyはSpotify APIをpythonで使用するためのライブラリ)

https://spotipy.readthedocs.io/en/latest/#Spotify APIのリファレンス

https://developer.spotify.com/documentation/web-api/reference-beta/Python使用環境

・spotipy 2.4.4

・numpy 1.15.4

・networkx 2.3

・matplotlib 3.0.2

・numpy 1.15.4アーティスト関係図の描画

アーティスト関係図について

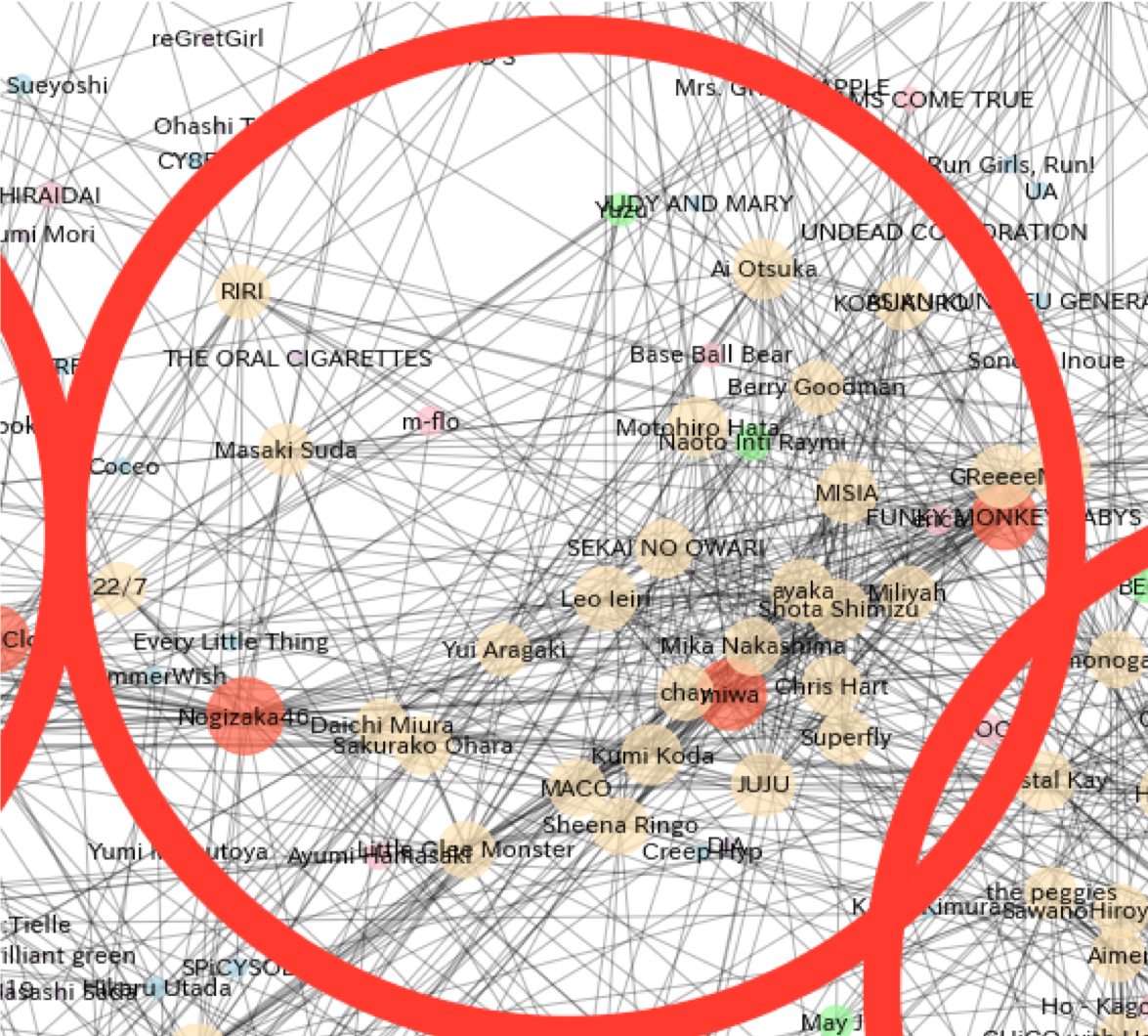

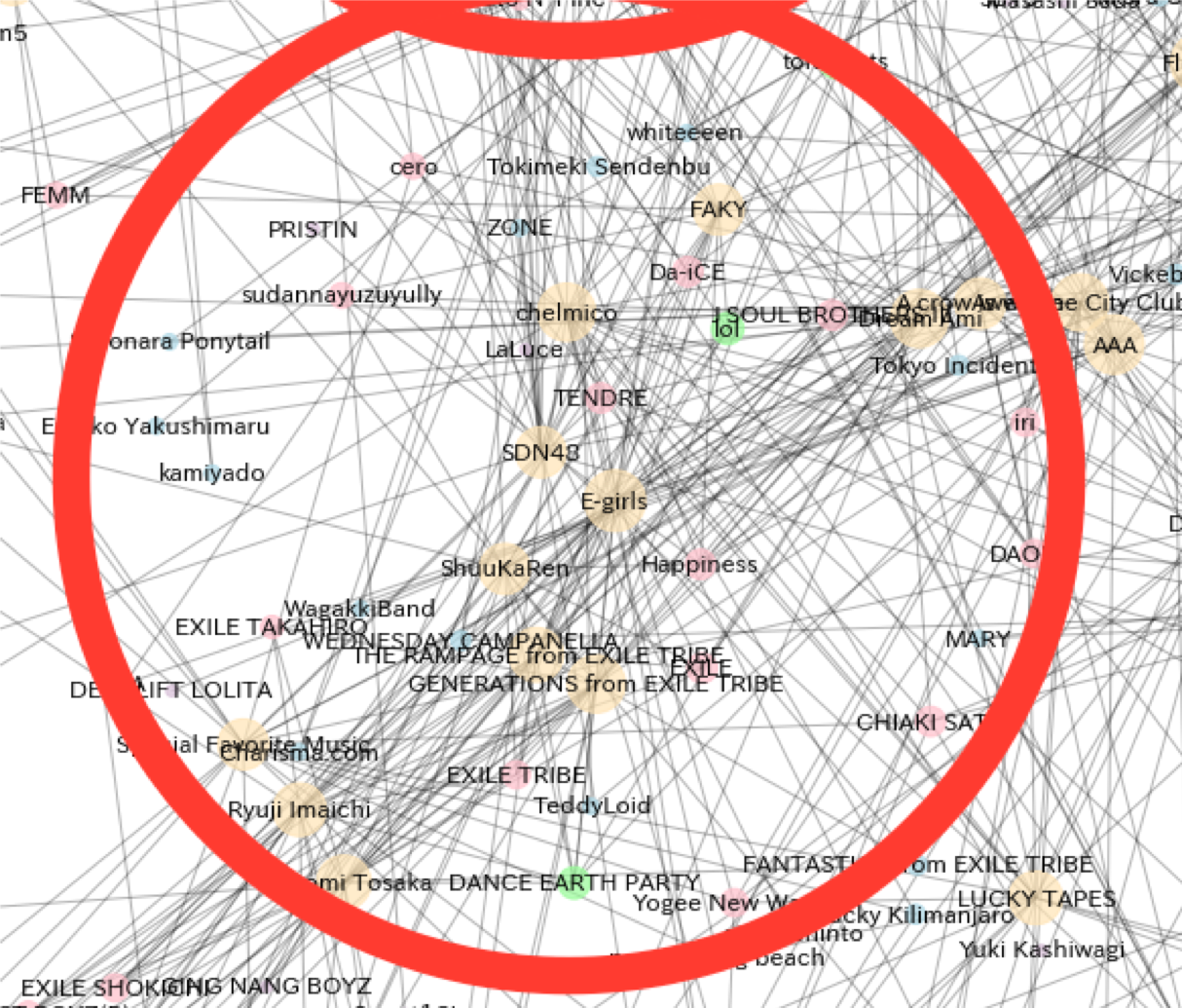

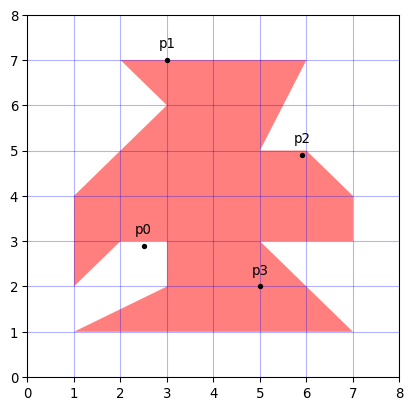

アーティスト関係図は乃木坂46を起点として、「乃木坂46の関連アーティスト」「乃木坂46の関連アーティストの関連アーティスト」という形式で辿っていくことで関係データを溜めていきます。それらを関係図の形で描画することで、乃木坂46を起点として「あるアーテイストを聞いている人が他によく聞いているアーティスト群」が一目でわかるのではないかという試みです。イメージはこんな感じです。

アーティスト関係図の描画実装

アーティスト関係図を描画するコードを実装します。

手順としては、まず起点となるアーティストのidからその関連アーティストのデータを取得します。

さらにその取得したアーティストの関連アーティストを辿って...という感じでぐるぐる回してデータを蓄積します。その後そのデータを用いて、networkxで関係図を描画すれば完成です。

下記が作成したコードです。至らない箇所も多いコードとは思いますがご了承ください。。。

事前に日本語が文字化けしないようにフォントを設定済みです。必要な方はこちらをご参照ください。import spotipy import matplotlib.pyplot as plt import networkx as nx from spotipy.oauth2 import SpotifyClientCredentials client_id = 'ここに自分のクライアントIDを記載' client_secret = 'ここに自分のシークレットキーを記載' client_credentials_manager = spotipy.oauth2.SpotifyClientCredentials(client_id, client_secret) spotipy.Spotify(client_credentials_manager=client_credentials_manager) spotify = spotipy.Spotify(client_credentials_manager=client_credentials_manager) class Spotify_Artists_info: def __init__(self, name): self.name = name self.related_artist = None #指定した名前のアーティストのidを取得する関数 def get_artist_uri(self): row = spotify.search(q='artist:' + self.name, type='artist')['artists']['items'][0]['uri'] uri = row.split(':')[2] #指定した名前のアーティストのuriを返す return uri #関連アーティストのデータを取得する関数 #sizeで何階層まで関連アーティストを辿るのかを指定 def relation_list(self, size): related_artist = [] #まず、指定のアーティストの直接の関連アーティストのデータを取得する for i in spotify.artist_related_artists(self.get_artist_uri())['artists']: related_artist.append([spotify.artist(self.get_artist_uri())['name'], i['name'], i['uri'].split(':')[2]]) #第二階層以上を辿る場合はここからぐるぐる回す if size > 1: count = 0 size = size-1 for i in range(size): head = count tail = len(related_artist) for uri in np.array(related_artist)[:,2][head:tail]: key_artist = spotify.artist(uri)['name'] for x in spotify.artist_related_artists(uri)['artists']: related_artist.append([key_artist,x['name'], x['uri'].split(':')[2]]) count += tail self.related_artist = related_artist else: self.related_artist = related_artist #描画の際のノードの色を変化させる関数 def fnc_color(self, siz): colorlist = ['tomato', "moccasin", "palegreen", "pink", "lightblue", "thistle","lightgrey", "w"] if siz >=1000: return colorlist[0] elif siz >=500: return colorlist[1] elif siz >=250: return colorlist[2] elif siz >= 100: return colorlist[3] elif siz >= 50: return colorlist[4] else: return colorlist[5] #アーティストの関係図を描画する関数 def generate_relation_map(self): for i in self.related_artist: G.add_edge(i[0], i[1]) plt.figure(figsize = [50, 50]) pos = nx.spring_layout(G, seed = 1, k = 0.2) #フォントは日本語が文字化けしないように、事前にダウンロード済み nx.draw_networkx_labels(G, pos, font_color='k', font_family='IPAexGothic') nx.draw_networkx_nodes(G, pos, alpha=0.7, node_shape="o", linewidths = 1, #次数中心性(そのノードから何本線が出ているか)を元にノードの大きさとサイズを指定 node_color = list(map(self.fnc_color ,[nx.degree_centrality(G)[i]*20000 for i in G.node])), node_size = [nx.degree_centrality(G)[i]*20000 for i in G.node]) nx.draw_networkx_edges(G, pos, alpha=0.3)描画

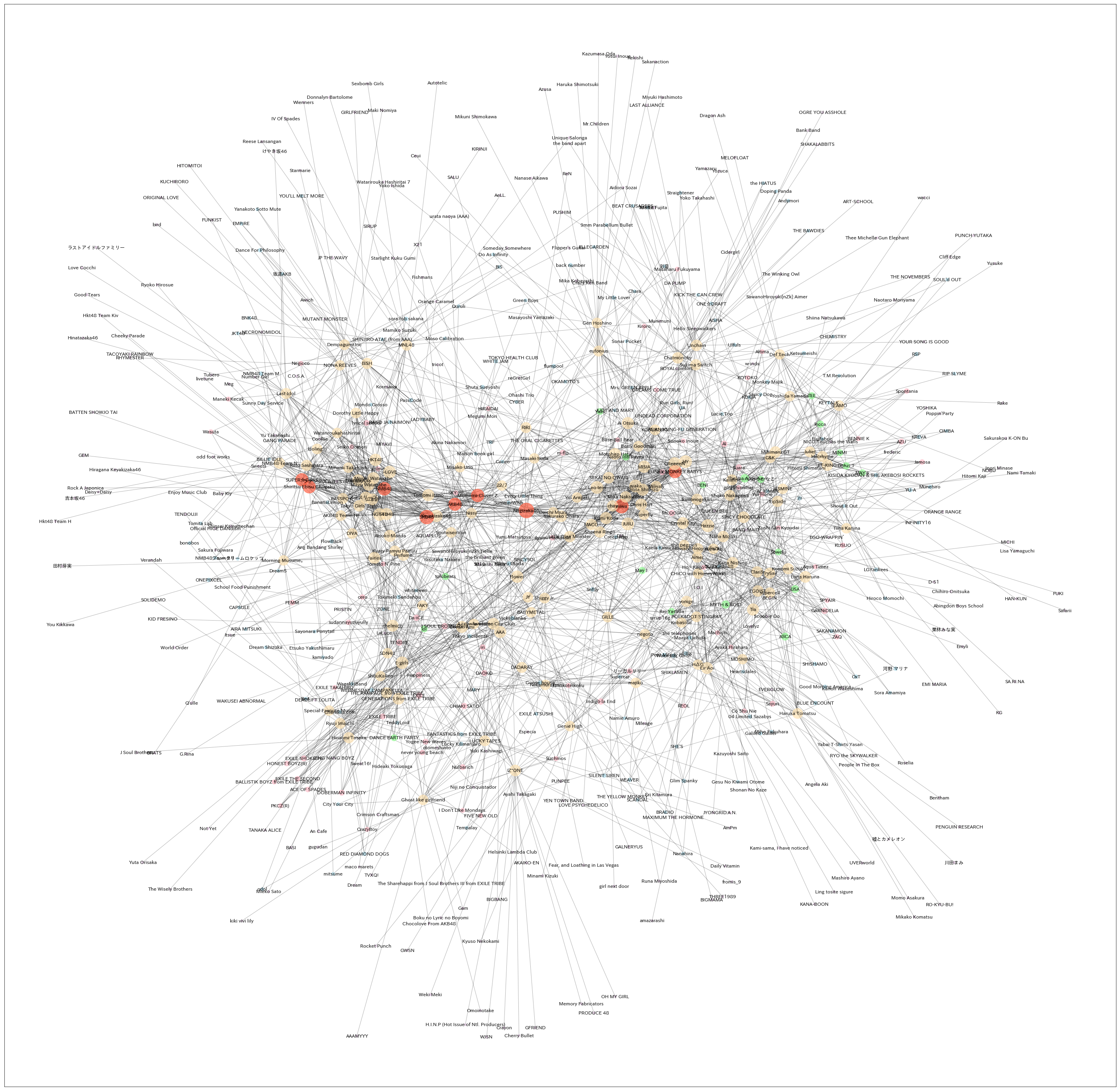

では、上記を用いて実際に乃木坂46を起点としてアーティスト関係図を描画してみます。

今回は、乃木坂を起点として第2階層までの描画とします。ちなみに階層を増やす毎にデータは指数関数的に増えていくため、その分非常に時間がかかります。s = Spotify_Artists_info('Nogizaka46') s.relation_list(2) s.generate_relation_map()描画した結果がこちら、

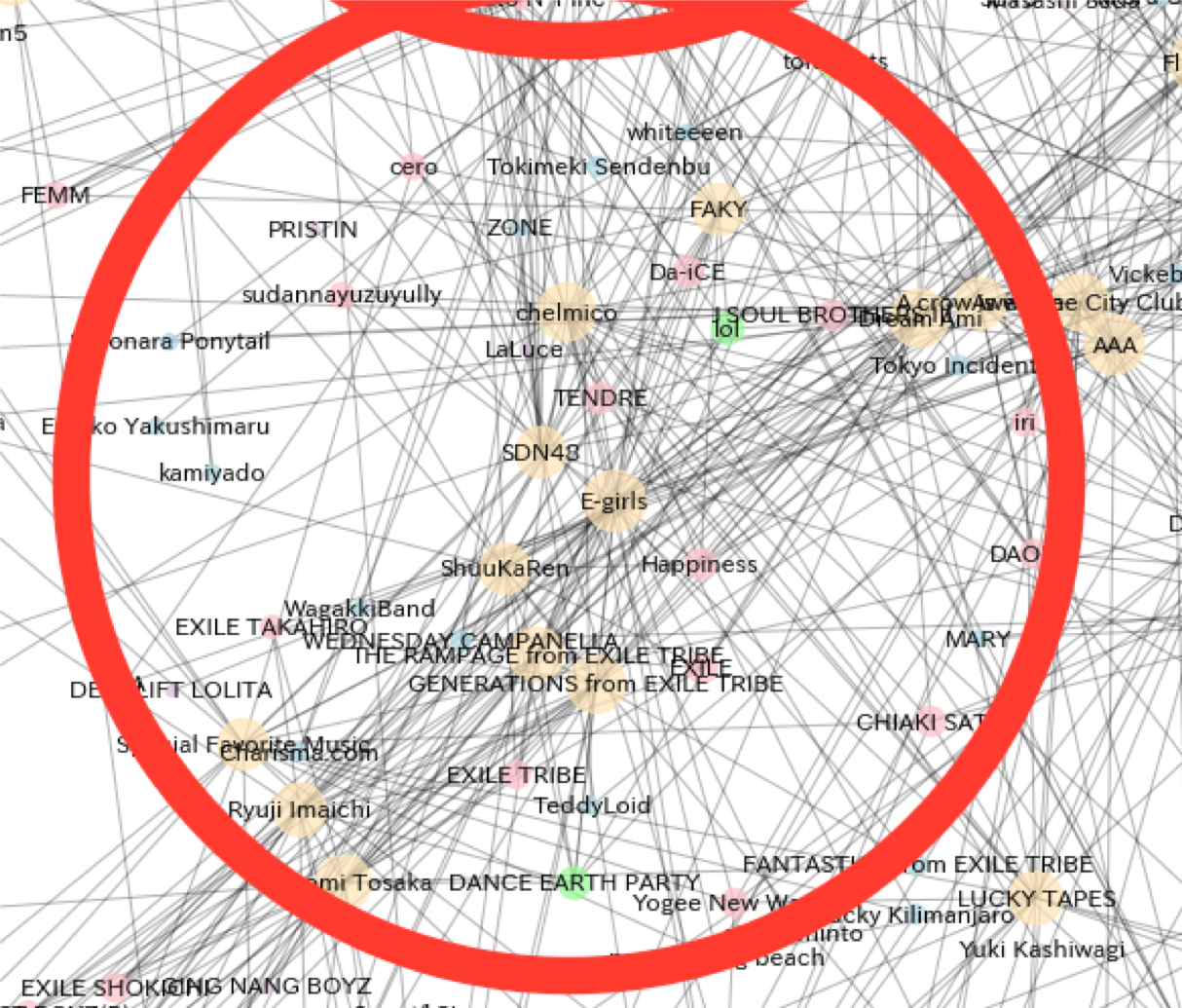

よくわからんけどなんかすごい。。。アーティスト関係図の中身を分析

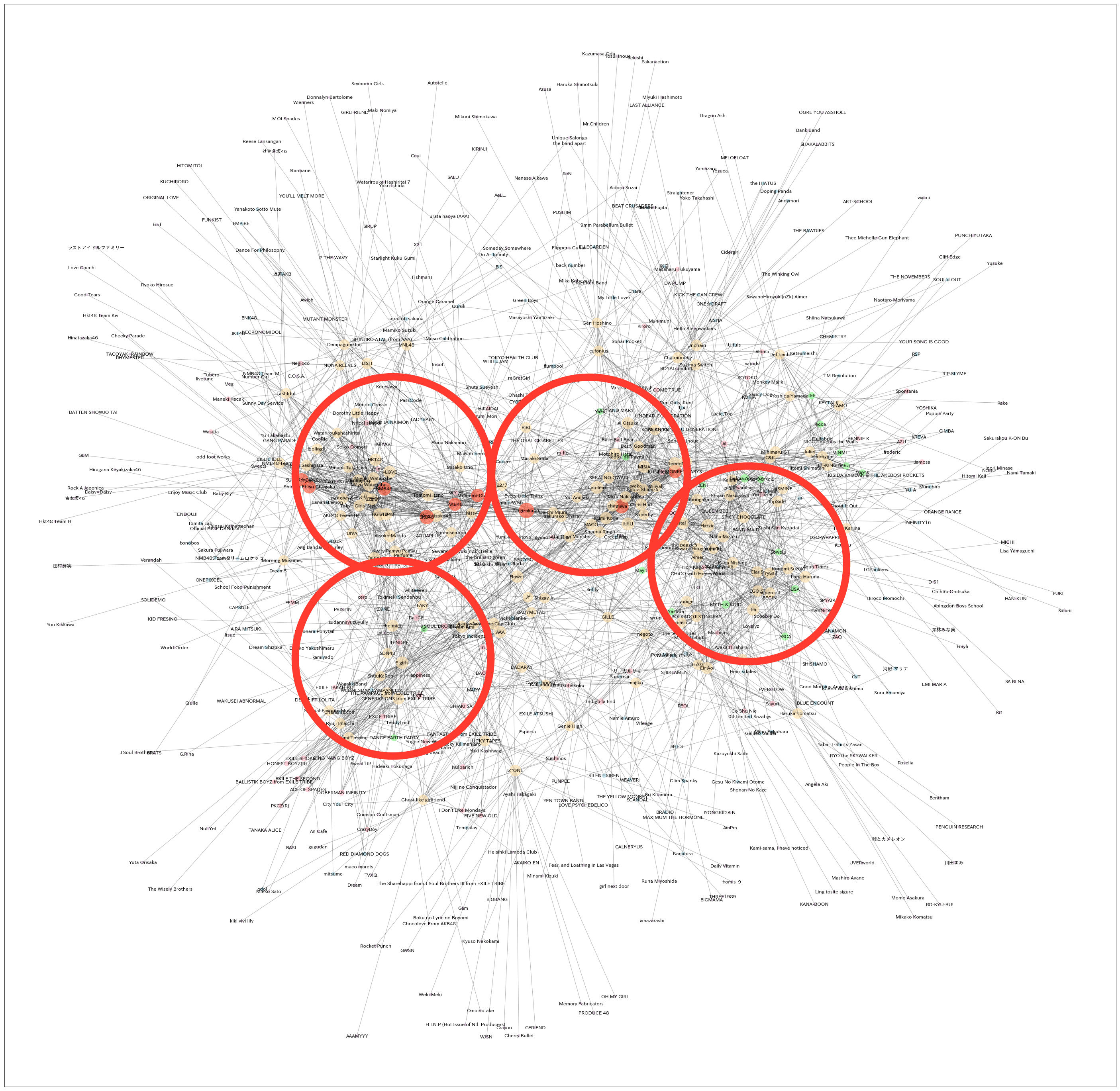

上記のアーティスト関係図ですが、よくよく見るとノード(丸のこと)が密集している箇所がいくつかあるのがわかります。

それぞれのクラスターについて少し詳しくみていきます。①アイドルクラスター

まず、1つ目のクラスターを見ていきます。少し重なっている部分が見にくくて恐縮ですが、48系グループを中心にアイドルグループが集まっていることがわかります。48系やその派生ユニットだけでなく、「SUPER GIRLS」や「私立恵比寿中学」など他系統のアイドルグループ存在しています。そんな中、乃木坂46は少しクラスターから外れているのがお分りでしょうか。(画像の右端にあります。)前回の投稿にも記載しましたが、乃木坂46のファン層は所謂アイドルファン層のみ、という状況を脱しつつあることがわかります。

②人気J-POPクラスター

続いて、乃木坂46が属しているクラスターです。中には、「SEKAI NO OWARI」や「miwa」、「GReeeeN」や「Superfly」など、既に人口に膾炙しているような人気J-POPアーティストが目立ちます。(筆者はあまり音楽知識がないため、本当はもっと適切な定義付けが可能かもしれません。また、「SEKAI NO OWARI」はJ-POPなのか、みたいな問題もあるような気がするので、何となく大衆のレベルで認知度がある、というくくりの方がよいかもしれません。)また、その中に乃木坂46が入っているのを見ると、やはりアイドルと枠を脱して大衆レベルの認知度を獲得しつつあるのかとなと思います。

③EXILEクラスター

3つ目は、「EXILE」や「EXILE TRIBE」、「E-girls」など株式会社LDH JAPAN(EXILEのHIROが創業)に所属するグループのクラスターです。面白いのは、このクラスターがJ-POPクラスタとあまり近い位置にない、という点です。筆者としては、「EXILE」や「E-girls」はもっとJ-POP寄りのところにあっても良いのかな、という感覚なのですが、実際は割とはっきりファン層は分かれており、EXILE系グループを支持する層というのが明確に存在するということでなんでしょう。

もうひとつクラスターがあるのですが、筆者の音楽スキルが足りないため定義づけは諦めました。。。みなさんの方で色々試してみてどんな関係図が現れるのか試していただければ楽しいと思います!

おわりに

やっぱりSpotify APIは色々できて楽しいで、他の切り口の分析にもチャレンジしていければと思います。

- 投稿日:2019-09-09T22:34:53+09:00

PythonでHTML解析(スクレイピング)

サイトリニューアルのとき、よくあるデータ移行があります。

手動作業はできますが、コストかかりますので、

バッチでHTML取得⇒解析⇒新システムに投入 というような機能が役に立つ場合があります。Javaでは、jsoupというライブラリは有名です。

Pythonでは、beautifulsoup4 というライブラリは有名です。jsoup: https://jsoup.org/

beautifulsoup4: https://pypi.org/project/beautifulsoup4/VSCodeのターミナルからインストール

pip install beautifulsoup4HTMLのfragmentの解析

解析サンプル

from bs4 import BeautifulSoup html = "<body><h1>PythonでHTML解析</h1><p>HTML解析の説明</p></body>" soup = BeautifulSoup(html, "html5lib") print(soup.h1)結果

<h1>PythonでHTML解析</h1>一点注意したいのは、ライブラリにあるファイルを自分のプロジェクトフォルダーに作成するとエラーになる可能性があります。

例えば、「bs4.py」というファイルを作成して実行しようとするとエラーです。URLから解析

from urllib.request import urlopen from bs4 import BeautifulSoup html = urlopen("https://news.yahoo.co.jp/").read() soup = BeautifulSoup(html, 'html.parser') # print(soup.prettify()) # jQueryと同じにセレクターを書く elements = soup.select(".topicsList li.topicsListItem a") for element in elements: print("title: " + element.text + ", href: " + element.get("href"))解析結果

title: 日産・西川社長 16日付で辞任, href: https://news.yahoo.co.jp/pickup/6336028 title: 日産社長退任 裏に激しい攻防, href: https://news.yahoo.co.jp/pickup/6336027 title: 停電続く千葉「耐えるしか」, href: https://news.yahoo.co.jp/pickup/6336024 title: 上皇后さま 術後の経過順調, href: https://news.yahoo.co.jp/pickup/6336026 title: ヤマト 住所なしで発送可能に, href: https://news.yahoo.co.jp/pickup/6336019 title: 経費削減 減りゆくテレビCM, href: https://news.yahoo.co.jp/pickup/6335992 title: 騒然 ロッテ井口監督が即退場, href: https://news.yahoo.co.jp/pickup/6336025 title: 3選手がメッシとの会話拒否か, href: https://news.yahoo.co.jp/pickup/6336029詳しい情報のURL:https://www.crummy.com/software/BeautifulSoup/bs4/doc/

以上

- 投稿日:2019-09-09T22:34:32+09:00

Raspberry PiとKV-7500で上位リンク通信

概要

Raspberry PiからKV-7500(keyence製PLC)にEtherNet/IPを利用してアクセスしてみました。

KV-7500の上位リンク通信機能を利用し、TCPサーバーとして機能します。

Raspberry PiはTCPクライアントとしてKV-7500と通信します。KV-7500の設定

ユニットエディタを開いて下記のように設定します。

機能

・ソケット通信:使用する

基本

・先頭DM番号:DM10000

・先頭リレー:R10000

・IPアドレス:固定IPアドレス(*)

・IPアドレス:192.168.0.10(デフォルトでOK)

・サブネットマスク:255.255.255.0(デフォルトでOK)ポート番号

・ポート番号(上位リンク):8501(デフォルトでOK)

あとの設定は特に変更する必要はなさそうです。

Raspberry Piの設定・プログラム

TCP/IPでKV-7500に接続して、コマンドを送信します。

KV-7500からの返答がきたら、結果を表示します。tcp-client.pyimport socket host_ip = '192.168.0.10' # kv-7500のIPアドレス host_port = 8501 # 上位リンク通信のポート番号 client = socket.socket(socket.AF_INET, socket.SOCK_STREAM) # socket.AF_INETでip4を使うことを指定。socket.SOCK_STREAMでTCPを使うことを指定。 client.connect((host_ip,host_port)) # サーバーに接続(kv-7500にTCP接続/上位リンク通信) comand = "?K" # 上位リンク通信のコマンド(これは機種の問い合わせコマンド) separator = "\r" # 区切り符号CRの16進数表記 msg = comand + separator client.send(msg.encode("ascii")) # 上位リンク通信のデータコードがASCIIなのでエンコード print("send : " + msg) response = client.recv(1024) response = response.decode("UTF-8") # PLCからの返答がbyteデータなのでUTF-8にデコード client.close() print("Received :" ,response)「Received:55」と表示され、これは、KV-7500を意味します。

終わりに

上位リンク通信を利用してRaspberry PiからKV-7500にコマンドを送り、機種を確認することができました。

KV-7500には機種問い合わせのほかにも、データ読み出しやデータ書き込みなどのコマンドが用意されているので、随時試していきます。

- 投稿日:2019-09-09T22:28:20+09:00

Chainer+OptunaでFashion MNISTの正解率を90%以上にしたい

Optunaとは

ハイパーパラメータの自動最適化フレームワークです。

Pythonで利用できます。

Optunaには3つの特徴があります。

① Define by RunスタイルのAPI

② 学習曲線を用いた試行の枝刈り

③ 並列分散最適化

要はコードが簡単に書け、改修もしやすく、速いってことです。

詳しくは公式ページで確認できます。今回やること

Fashion MNISTのテスト正解率が90%以上となるハイパーパラメータを、Optunaにて探索します。

Qiita記事「ChainerでFashion mnistのテスト精度を90%以上にする」を参考にしました。実験条件

実験条件の縛りは上記記事と同様です。

- データセットはFashion MNIST(MNISTの衣類版。サイズ、枚数はMNISTと同じ。訓練50,000枚、テスト10,000枚。)

- Google Colaboratory上(GPU)で実行

- エポック数10以下

- 訓練時間100秒以内

- ネットワークは全結合層のみ

その他の確定条件は以下のようにします。

- 活性化関数はRelu関数

- 5エポック後、学習率に1/10をかける

- 試行回数は100

自動最適化を行うパラメータは以下のものとします。

- ネットワークの層数:1~6

- 各ユニットのノード数:100~4000

- オプティマイザ:MomentumSGD, Adam

- 学習率:1e-5~1e-1

- バッチサイズ:50, 100, 200, 500

また、PRUNER_INTERVALを3とします。

つまり、3エポック毎に学習曲線をチェックし、見込みがなければその試行を中止します。コード

コードは以下の通りです。

ほぼ、Optunaの公式exampleのコピーです。import chainer import chainer.functions as F import chainer.links as L import numpy as np import optuna from time import time EPOCH = 10 PRUNER_INTERVAL = 3 def create_model(trial): n_layers = trial.suggest_int('n_layers', 1, 6) layers = [] for i in range(n_layers): n_units = int(trial.suggest_loguniform( 'n_units_l{}'.format(i), 100, 4000)) layers.append(L.Linear(None, n_units)) layers.append(F.relu) layers.append(L.Linear(None, 10)) return chainer.Sequential(*layers) def create_optimizer(trial, model): optimizer_name = trial.suggest_categorical('optimizer', ['Adam', 'MomentumSGD']) if optimizer_name == 'Adam': adam_alpha = trial.suggest_loguniform('adam_alpha', 1e-5, 1e-1) optimizer = chainer.optimizers.Adam(alpha=adam_alpha) else: momentum_sgd_lr = trial.suggest_loguniform('momentum_sgd_lr', 1e-5, 1e-1) optimizer = chainer.optimizers.MomentumSGD(lr=momentum_sgd_lr) optimizer.setup(model) return optimizer def objective(trial): gpu_id = 0 model = L.Classifier(create_model(trial)) model.to_gpu(gpu_id) optimizer = create_optimizer(trial, model) rng = np.random.RandomState(0) batchsize = trial.suggest_categorical( 'batchsize', [50, 100, 200, 500]) train, test = chainer.datasets.fashion_mnist.get_fashion_mnist() train_iter = chainer.iterators.SerialIterator(train, batchsize) test_iter = chainer.iterators.SerialIterator( test, batchsize, repeat=False, shuffle=False) updater = chainer.training.StandardUpdater( train_iter, optimizer, device=gpu_id) trainer = chainer.training.Trainer(updater, (EPOCH, 'epoch')) optimizer_name = trial.params["optimizer"] if optimizer_name == "MomentumSGD": trainer.extend(chainer.training.extensions.ExponentialShift('lr', 0.1), trigger=(5, 'epoch')) else: trainer.extend(chainer.training.extensions.ExponentialShift('alpha', 0.1), trigger=(5, 'epoch')) trainer.extend(optuna.integration.ChainerPruningExtension( trial, "validation/main/loss", (PRUNER_INTERVAL, "epoch"))) trainer.extend(chainer.training.extensions.Evaluator( test_iter, model, device=gpu_id)) log_report_extension = chainer.training.extensions.LogReport(log_name=None) trainer.extend( chainer.training.extensions.PrintReport([ 'epoch', 'main/loss', 'validation/main/loss', 'main/accuracy', 'validation/main/accuracy' ])) trainer.extend(log_report_extension) trainer.run(show_loop_exception_msg=False) log_last = log_report_extension.log[-1] for key, value in log_last.items(): trial.set_user_attr(key, value) val_err = 1.0 - log_report_extension.log[-1]['validation/main/accuracy'] return val_err if __name__ == "__main__": start = time() study = optuna.create_study() study.optimize(objective, n_trials=100) elapsed_time = time() - start print("elapsed_time:", elapsed_time) print('Number of finished trials: ', len(study.trials)) print('Best trial:') trial = study.best_trial print(' Value: ', trial.value) print(' Params: ') for key, value in trial.params.items(): print(' {}: {}'.format(key, value)) print(' User attrs:') for key, value in trial.user_attrs.items(): print(' {}: {}'.format(key, value))実験結果

ベストパラメータは以下のようになりました。

- ネットワークの層数:2

- 各ユニットのノード数:[unit1: 3145, unit2: 3846]

- オプティマイザ:Adam

- 学習率:4.156e-4

- バッチサイズ:100

ベストパラメータでの結果は以下の通りです。

- 訓練正解率:94.42%

- テスト正解率:90.40%

- 学習時間:70秒

無事、条件を満たしつつテスト正解率を90%以上にすることができました。

考察

今回は特徴②の枝刈りを用いました。

100回の試行での総学習時間は2904秒でした。

単純計算で70x100=7,000秒程かかっておかしくないので、枝刈りが非常に時間短縮に役立っていると考えられます。ただ、オプティマイザは

- MomentumSGDは、学習は遅いが汎化性能が高い

- Adamは、学習は速いが汎化性能が低い

という特徴があるので、「MomentumSGDで学習が遅くても最終的に正解率が良くなるもの」も枝刈りされてしまった可能性があります。

そういった意味では、この枝仮はMomentumSGDにとって不利であったかもしれません。

そこらへんの枝刈り問題は、結構難しいらしいです。

(参照:OptunaのPruningが抱える課題)また、バッチサイズをある程度小さくすると正解率が良くなります。

上記のコードとは別に、今回の範囲よりも小さいバッチサイズを候補に入れたときは、正解率がより良くなりました。(バッチサイズが16のとき)

ただし、学習時間が100秒を余裕で超えてしまいました。

バッチサイズを小さくするとオプティマイザによる更新回数が増えるからなんでしょうね。

ここらへんは、時間との相談です。まとめ

Optunaは、ほんと便利です。

手動ではとてもできないようなハイパーパラメータを探し出してくれます。

ただし、ある程度のハイパーパラメータ調整に関する知識(モデルの大枠の組み方や学習率のスケジューリングなど)は必要です。

モデルやハイパーパラメータの大枠は自分で決めて、Optunaを使って細かい調整をしていくのが良い使い方なんだと思います。

- 投稿日:2019-09-09T21:54:48+09:00

【エラー対処】pyenvでinstallができなくなった

はじめに

以前pyenv, pyenv-virtualenvをインストールした記事を書いており、

これからはAnaconda依存ではなくバージョンごとに環境が変えられるなぁ〜と思っていました。しかし、すぐさまエラーが発生してしまいました。

原因は複数考えられますが

- 先日、Macのアカウント名を変更した(調べれば分かりますが、結構面倒で、アカウント変更後も不具合が多く出て、修復に大事時間が取られました。)

- bashをやめてfishにした。

が大きな要素かと思っています。

エラー内容

pyenv install 3.7.3 python-build: use openssl@1.1 from homebrew python-build: use readline from homebrew Downloading Python-3.7.3.tar.xz... -> https://www.python.org/ftp/python/3.7.3/Python-3.7.3.tar.xz Installing Python-3.7.3... python-build: use readline from homebrew python-build: use zlib from xcode sdk BUILD FAILED (OS X 10.14.5 using python-build 20180424) Inspect or clean up the working tree at /var/folders/q0/x66vgv1s6d1bf5rh1b0f79cc0000gn/T/python-build.20190909205347.67210 Results logged to /var/folders/q0/x66vgv1s6d1bf5rh1b0f79cc0000gn/T/python-build.20190909205347.67210.log Last 10 log lines: File "/var/folders/q0/x66vgv1s6d1bf5rh1b0f79cc0000gn/T/tmpqib00zdi/pip-19.0.3-py2.py3-none-any.whl/pip/_internal/cli/cmdoptions.py", line 22, in <module> File "/var/folders/q0/x66vgv1s6d1bf5rh1b0f79cc0000gn/T/tmpqib00zdi/pip-19.0.3-py2.py3-none-any.whl/pip/_internal/utils/hashes.py", line 10, in <module> File "/var/folders/q0/x66vgv1s6d1bf5rh1b0f79cc0000gn/T/tmpqib00zdi/pip-19.0.3-py2.py3-none-any.whl/pip/_internal/utils/misc.py", line 21, in <module> File "/var/folders/q0/x66vgv1s6d1bf5rh1b0f79cc0000gn/T/tmpqib00zdi/pip-19.0.3-py2.py3-none-any.whl/pip/_vendor/pkg_resources/__init__.py", line 35, in <module> File "/private/var/folders/q0/x66vgv1s6d1bf5rh1b0f79cc0000gn/T/python-build.20190909205347.67210/Python-3.7.3/Lib/plistlib.py", line 65, in <module> from xml.parsers.expat import ParserCreate File "/private/var/folders/q0/x66vgv1s6d1bf5rh1b0f79cc0000gn/T/python-build.20190909205347.67210/Python-3.7.3/Lib/xml/parsers/expat.py", line 4, in <module> from pyexpat import * ModuleNotFoundError: No module named 'pyexpat' make: *** [install] Error 1pythonを新しくpyenvでinstallしようとすると、エラーが発生し

ModuleNotFoundError: No module named 'pyexpat'がないと勧告されます。

とりあえずfishをやめる

fishはbashと同じでシェルの仲間ですが、.bash_profileを読み込んでくれないそうです。

正確には、文法が異なる、といったほうが正しいのかもしれません。よって、下記のコマンドでbashにデフォルトシェルを戻しました。

chsh -s /bin/bashchshはデフォルトシェルを変更するコマンドです。

XcodeのCommandLineToolのBeta版を入れる

https://qiita.com/karon9/items/875b8a0053fa1c685386

のサイトを参考にhttps://developer.apple.com/download/more/?=command%20line%20tools

からCommand Line Tools for Xcode Betaの最新版をダウンロード・インストールする。

その結果

ganariya$ pkgutil --pkg-info=com.apple.pkg.CLTools_Executables package-id: com.apple.pkg.CLTools_Executables version: 11.0.0.0.1.1565314599 volume: / location: / install-time: 1568031534 groups: com.apple.FindSystemFiles.pkg-groupとなり、バージョンが上がり

ganariya$ pyenv install 3.7.3 python-build: use openssl@1.1 from homebrew python-build: use readline from homebrew Installing Python-3.7.3... python-build: use readline from homebrew python-build: use zlib from xcode sdk Installed Python-3.7.3 to /usr/local/var/pyenv/versions/3.7.3無事インストール完了できた。うれしい。

まとめ

Fishを使うとBashの.bash_profileがきちんと読み込めない。

(これは、文法がちがうため)また、MacでCommand Lineツールのエラーで上記のエラーが出るので新しいバージョンを入れればきちんとインストールできる。

(ただ、もともとはうまく言ってて、アカウント名を変更したらこうなったので、多分アカウント名の変更時になんか変な事になってたんだと思う。)

- 投稿日:2019-09-09T21:14:14+09:00

selenium + python + chrome を用いたWebブラウザの操作(実サイトを用いたハンズオン)

はじめに

Pythonのseleniumモジュールを使用して、Chromeを操作する方法をまとめています。

Pythonの基礎がわかる人であれば理解できる内容にしています。

実在するサイトを用いて操作手順を記載しています。注意事項として、変なプログラム(連続してリクエストを投げるなど)を実行してしまうとWebサイトに負荷がかかる可能性があります。また、DoS攻撃と判断される可能性もあります。

プログラムを実行する前には間違いがないか注意してください。seleniumインストール

インストール方法は以下を参照してください。

[selenium向け] ChromeDriverをpipでインストールする方法(パス通し不要、バージョン指定可能)

https://qiita.com/hanzawak/items/2ab4d2a333d6be6ac760[超図解]AnacondaインストールからPythonプログラム実行までの手順(Windows版)

https://qiita.com/hanzawak/items/9dedcde1a43aa7d0e71aselenium概要

seleniumはWebサイトのテストを自動化するためのツールです。

以下の流れでブラウザを操作します。

- 操作したいブラウザを開く

- 操作したいページを開く

- 操作したい要素を確認する

- 操作したい要素を指定する

- 操作したい要素を操作する

selenium基本操作

0. seleniumインポート

from selenium import webdriver import chromedriver_binary # ChromeDriverをpipでインストールした場合はchromedriver_binaryもインポートしてください1. 操作したいブラウザを開く

まずはブラウザを開きます。

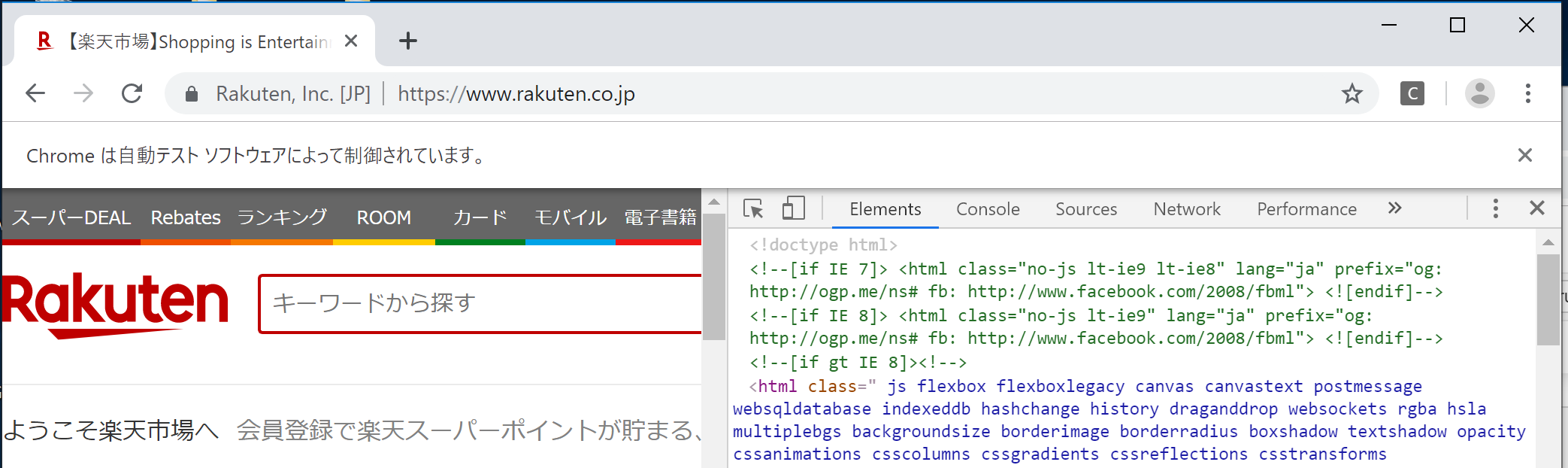

driver = webdriver.Chrome()以下のような画面が表示されます。

2. 操作したいページを開く

操作したいページを開きます。今回は楽天を開きます。

driver.get("https://rakuten.co.jp")楽天が開きます。

3. 操作したい要素を確認する

「キーワードから探す」の部分に文字を入力してみたいと思います。

「キーワードから探す」の要素を確認するには、ページのソースを見る必要があります。

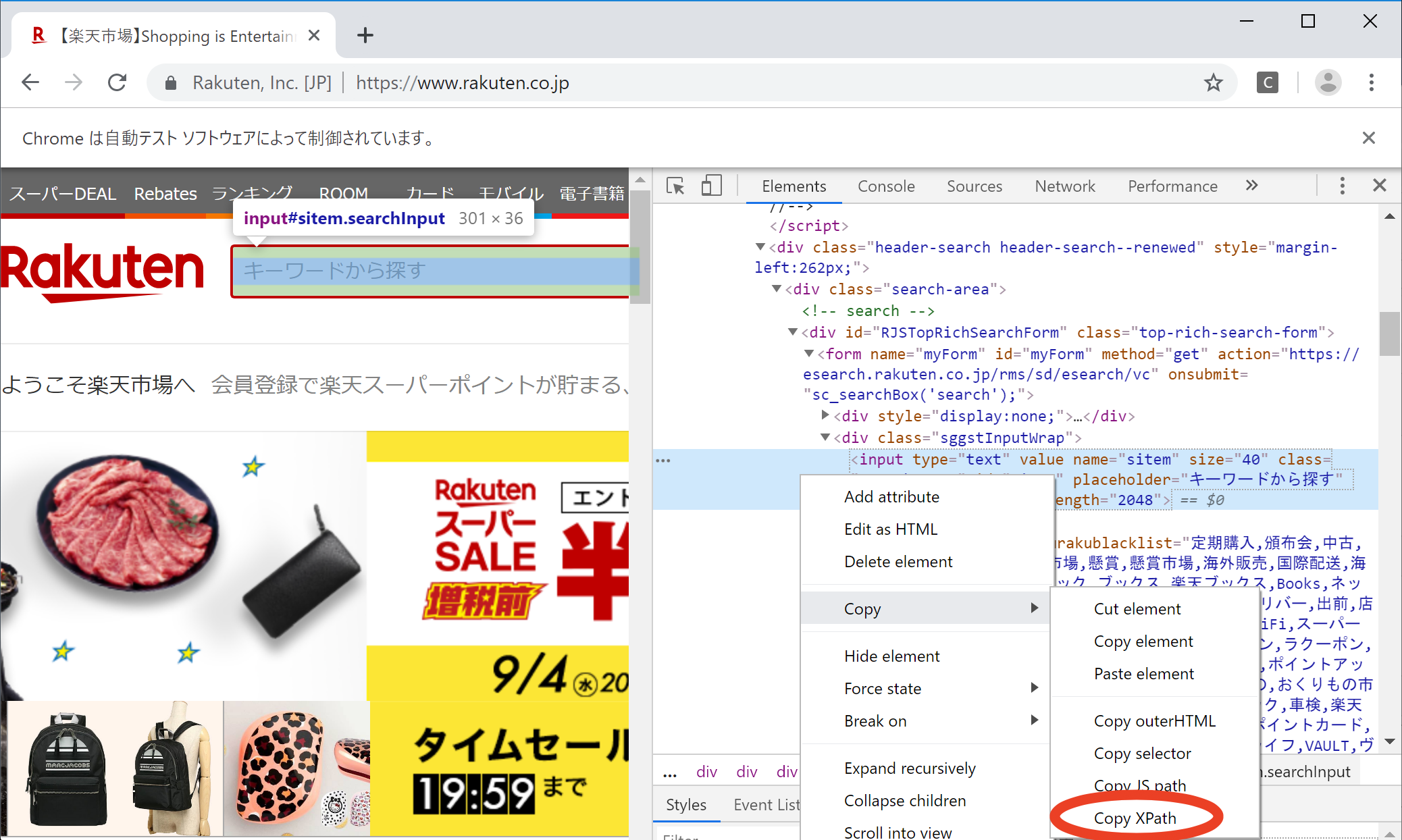

Chromeの場合は開発者ツールを用いることで簡単に確認できますので、その使用方法を記載します。I. F12キーをクリックする

画面右側に開発者ツールが開きます。

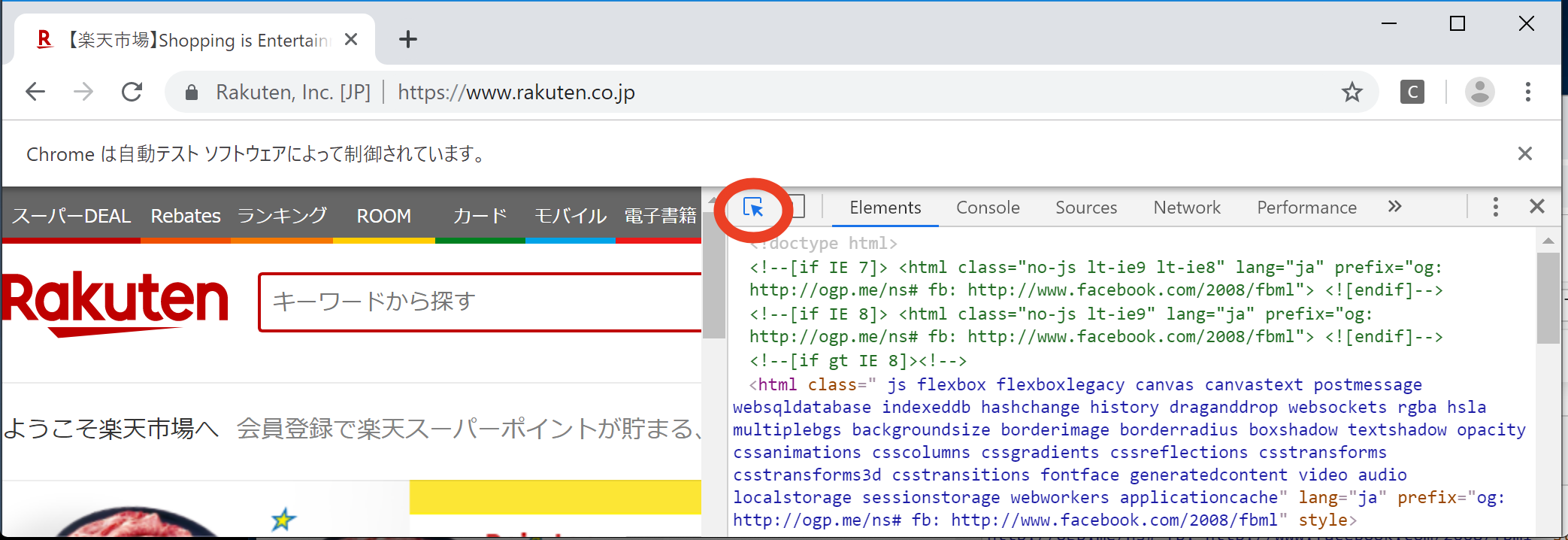

II. マウスカーソルボタンをクリックする

以下の赤丸部分を1回クリックしてください。するとマウスカーソルボタンが青色になります。

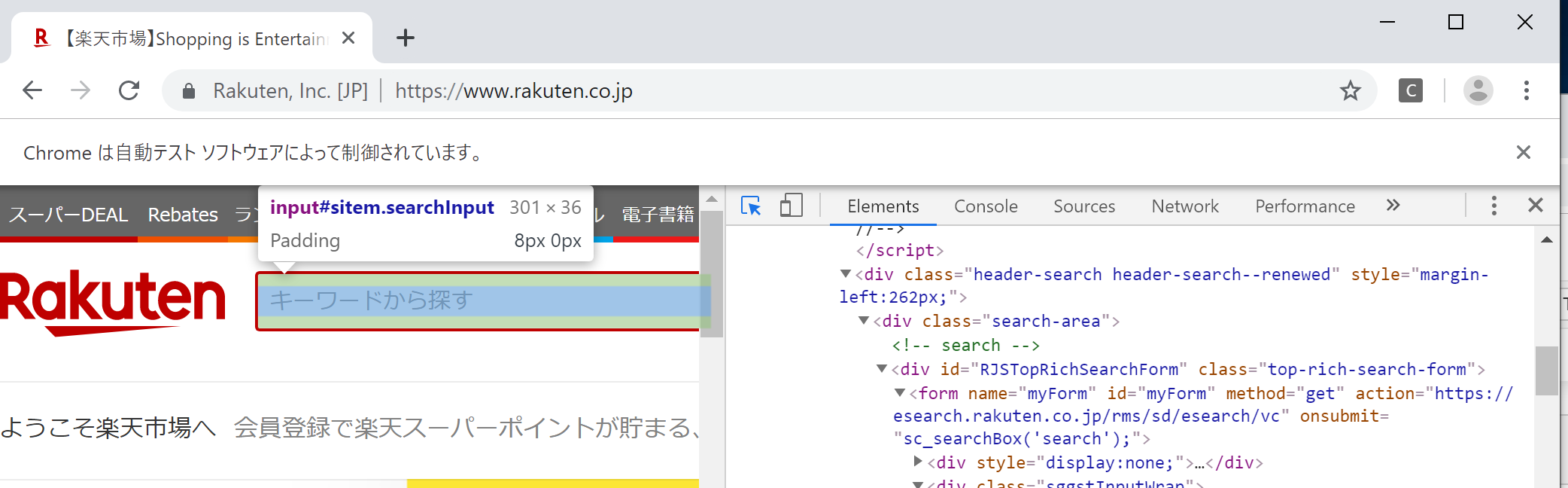

III. 要素を確認したい箇所をクリックする

マウスカーソルボタンが青色の状態の時に、左側の画面で要素を確認したい箇所をクリックしてください。

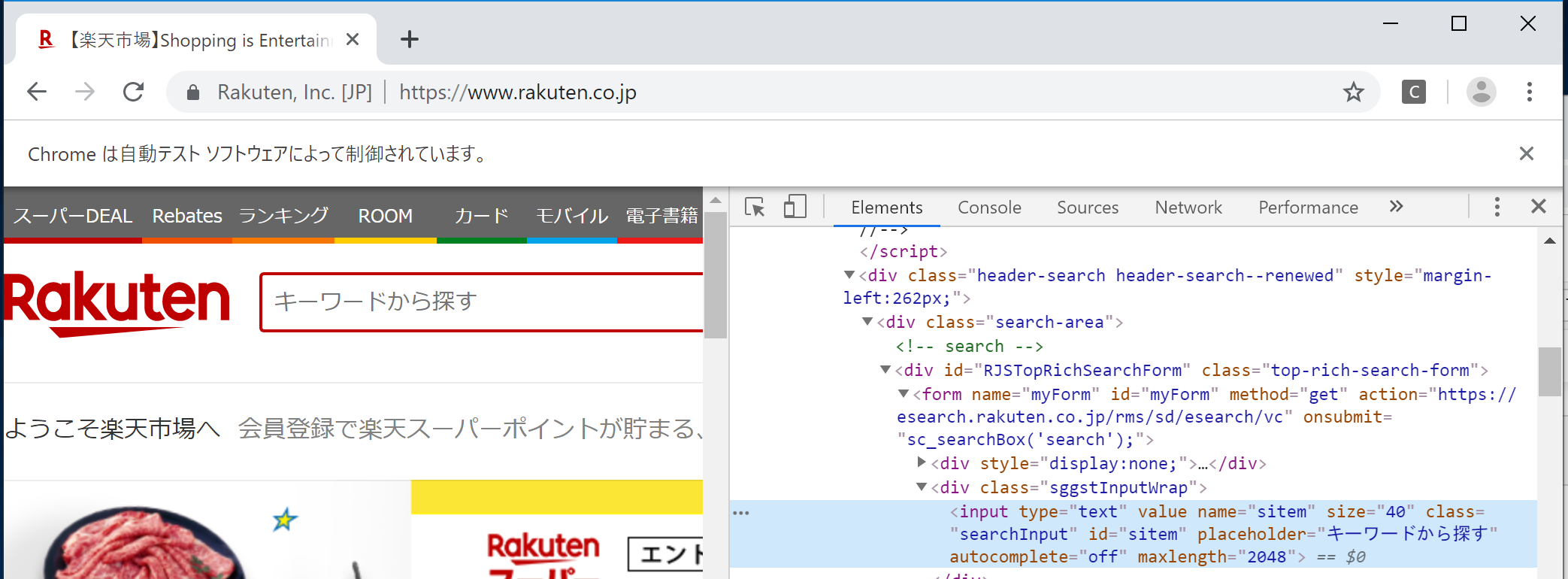

今回はキーワードを入力したいので、「キーワードから探す」の部分をクリックします。IV. ソースを確認する

画面右側の一部が青くハイライトされています。

この部分が「キーワードから探す」のソースです。V. 要素を確認する

以下は「キーワードから探す」のソースの部分です。

<input type="text" value="" name="sitem" size="40" class="searchInput" id="sitem" placeholder="キーワードから探す" autocomplete="off" maxlength="2048">seleniumで操作する際に使用できる要素としては以下がありました。

- name="sitem"

- class="searchInput"

- id="sitem"

上記以外にもXPathというXMLの特定の部分を指定する方法があります。

(XPathはソースに表示されません)

確認方法は、画面右側の青くハイライトされた部分を右クリックし、Copy→Copy XPath で確認できます。コピーした内容は

//*[@id="sitem"]でした。4. 操作したい要素を指定する

前の項目で取得できた以下4つの要素のいずれかを用いて、操作したい要素を指定します。

- name="sitem"

- class="searchInput"

- id="sitem"

- XPath -> //*[@id="sitem"]

今回はclassで要素を指定します。

x = driver.find_element_by_class_name('searchInput')5. 操作したい要素を操作する

「switch lite」という文字を入力する場合は以下のようにします。

x.send_keys('switch lite')以上がseleniumを使用する際の基本操作です。

要素を確認して、指定して、操作する、というだけの流れです。selenium応用

まずはselenium基礎のコマンドについて、もう少し他の方法がありますのでその説明をします。

要素指定と要素の操作を1つにまとめる

「4. 操作したい要素を指定する」と「5. 操作したい要素を操作する」は2つの処理を1行にすることができます。

以下のように記載すると、「キーワードから探す」を指定して、「switch lite」を入力できます。driver.find_element_by_class_name('searchInput').send_keys('switch lite')class_name以外の要素の指定

「4. 操作したい要素を指定する」ではclass_nameを指定しましたが、name, id, XPathでは以下のようにして指定ができます。

driver.find_element_by_name('sitem').send_keys('switch lite') driver.find_element_by_id('sitem').send_keys('switch lite') driver.find_element_by_xpath('//*[@id="sitem"]').send_keys('switch lite')seleniumを使用した色々なブラウザ操作

入力されている文字を消す

「キーワードから探す」に入力されている文字を消す方法です。

class_name, name, id, xpathの順で記載しています。driver.find_element_by_class_name('searchInput').clear() driver.find_element_by_name('sitem').clear() driver.find_element_by_id('sitem').clear() driver.find_element_by_xpath('//*[@id="sitem"]').clear()ボタンのクリック

検索ボタンをクリックしてみたいと思います。

前の手順と同じように開発者ツールから検索ボタンの様子を確認すると、class=searchBtnでした。

そのためclass_nameでsearchBtnを指定し、末尾にclick()をつけるとボタンをクリックできます。driver.find_element_by_class_name('searchBtn').click()値段の一覧を取得

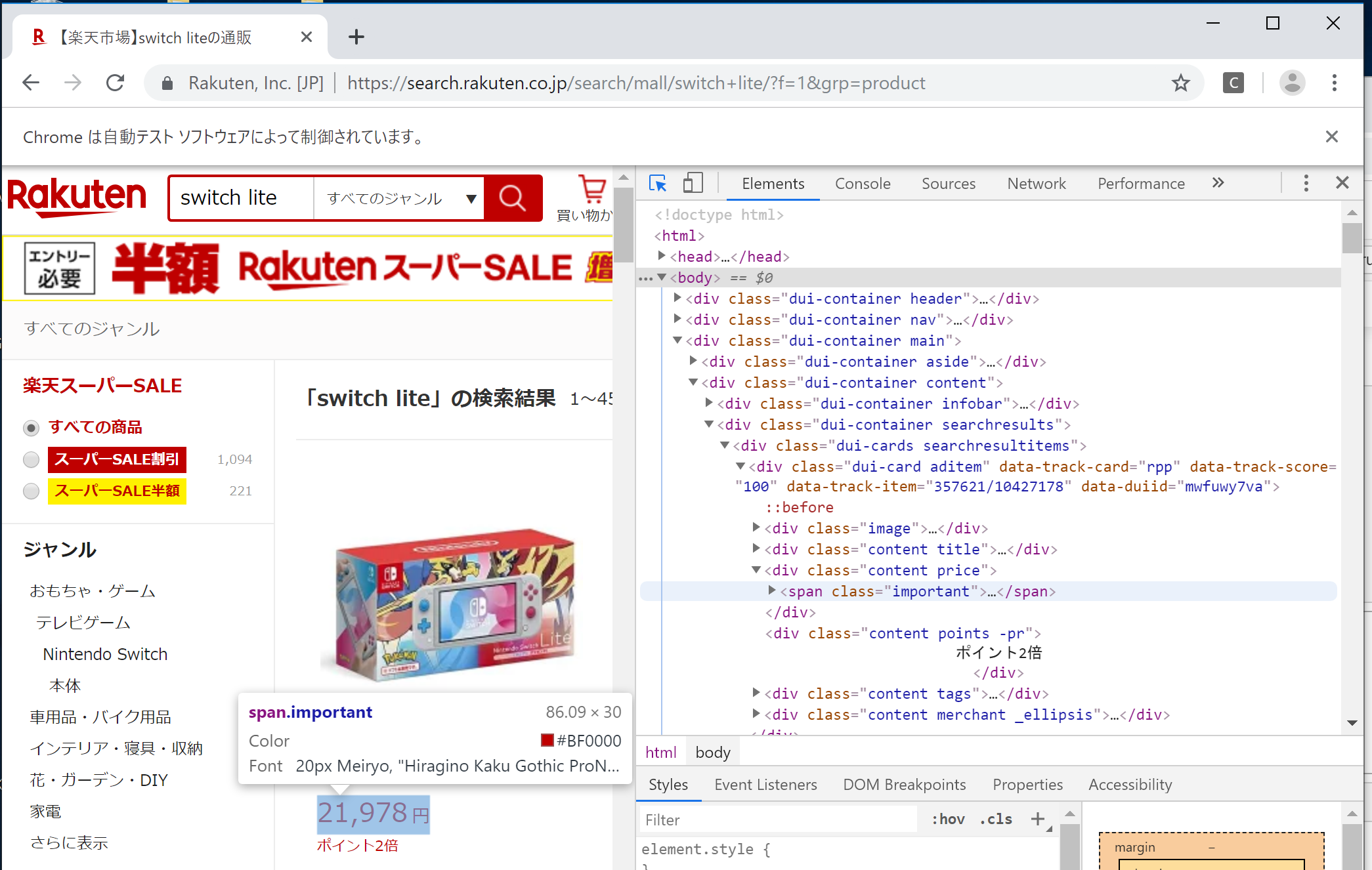

いつも通り開発者ツールからマウスカーソルボタンを押して、今度は値段の部分をクリックします。

するとclass=importantであることがわかります。テキストの情報を取得するには以下のように記載します。末尾が

textになります。driver.find_element_by_class_name('important').textこれを実行すると「21,978円」と表示されます。

次に2件目の値段を取得するために、開発者ツールからマウスカーソルボタンを押して、2件目の値段の部分をクリックします。まさかの2件目も

class=importantでした。

この場合、今までの方法ですと2件目の値段が取得できません。

どうやって解決するかというと、elementをelementsというように末尾にsをつけます。そして.textの前を[0][1]といったようにします。

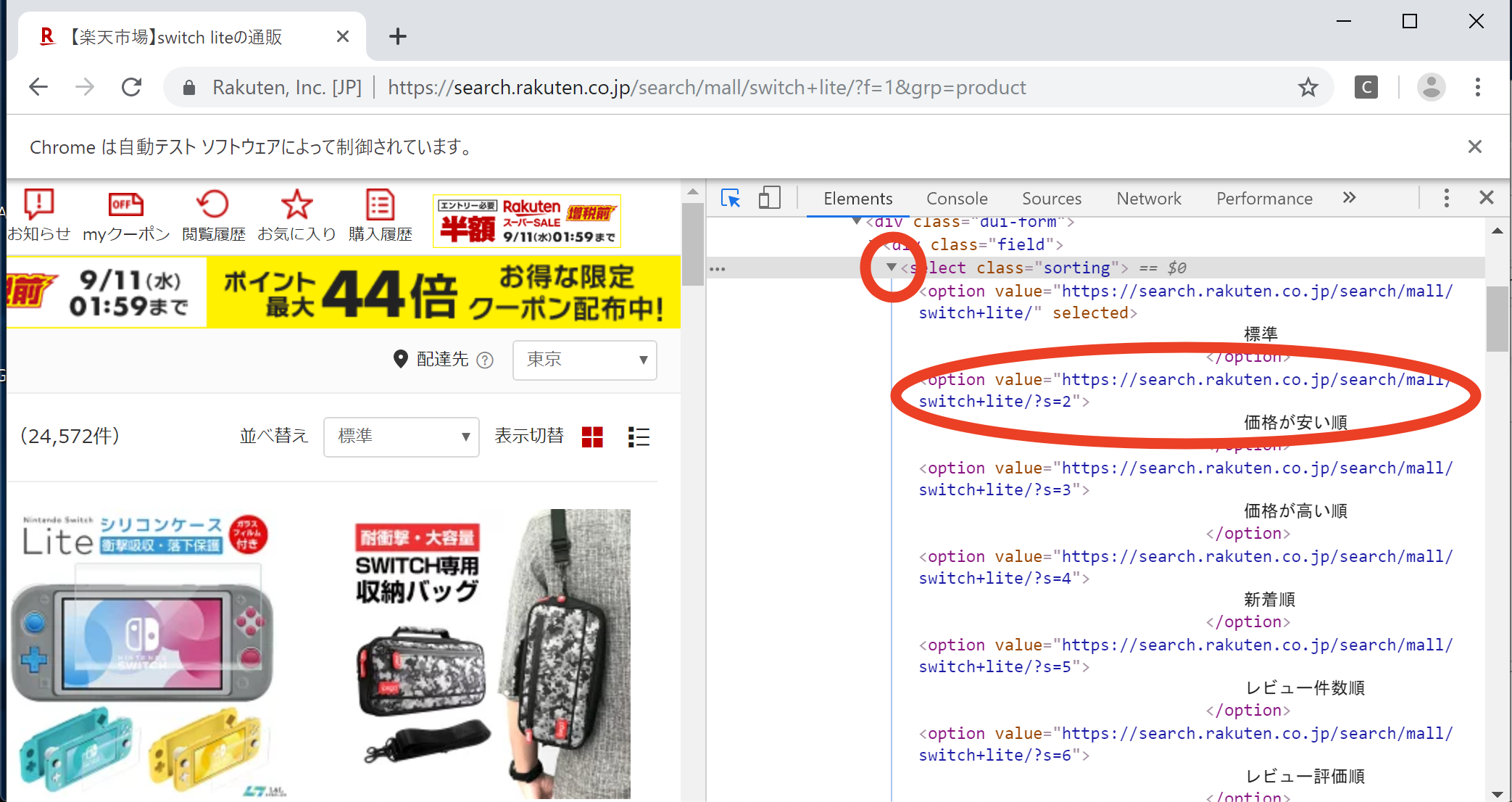

以下のようにすると値段の1件目、2件目、3件目が取得できます。driver.find_elements_by_class_name('important')[0].text driver.find_elements_by_class_name('important')[1].text driver.find_elements_by_class_name('important')[2].textなぜか楽天の検索結果には「1〜45件」と記載されていますが、数えてみると48件表示されていますので、以下のようにすると

pricesに全ての価格を記録できます。prices = [] for i in range(48): prices.append(driver.find_elements_by_class_name('important')[i].text) print(prices)楽天が修正する可能性を考えると以下のようにtry-exceptを使用した方が安全かもしれません。

prices = [] i = 0 while True: try: prices.append(driver.find_elements_by_class_name('important')[i].text) i += 1 except: breakプルダウンメニューの操作

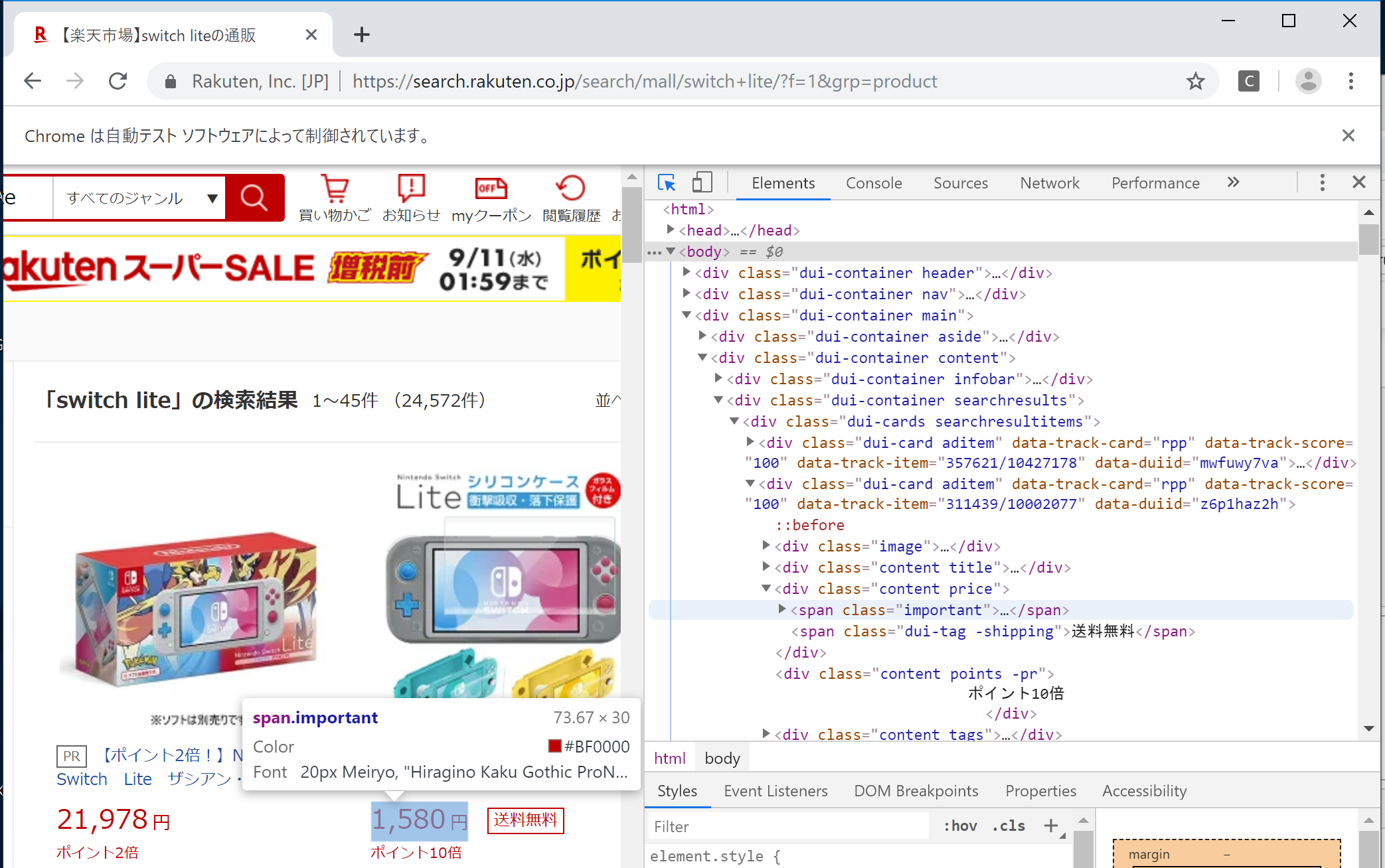

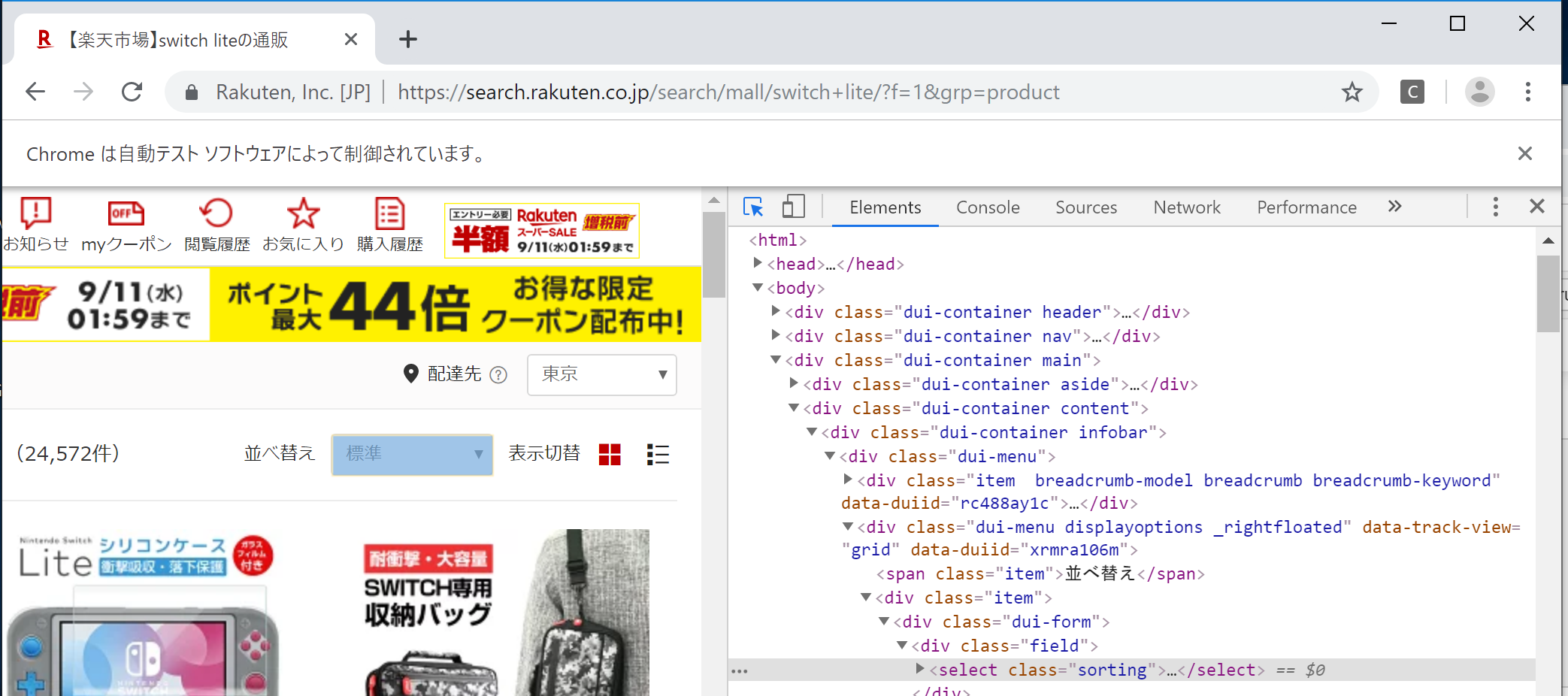

価格のソートをしてみようと思います。

プルダウンメニューを操作する時には、「要素」と「変更したいvalue」の情報が必要になります。「要素」はいつものように「並べ替え」の横の「標準」の部分で調べると、

class=sortingということがわかります。「変更したいvalue」は

class=sortingの左側の三角ボタンを押して詳細を表示し、その中からvalueを選択します。

今回は「価格が安い順」にしてみたいのでvalueはhttps://search.rakuten.co.jp/search/mall/switch+lite/?s=2ということになります。「要素」と「変更したいvalue」の情報が入手できましたのでプルダウンメニューを操作します。

以下のように記載すると「価格が安い順」が選択されます。

なおSelectをインポートする必要があります。from selenium.webdriver.support.ui import Select price_sort = driver.find_element_by_class_name('sorting') price_sort_select = Select(price_sort) price_sort_select.select_by_value('https://search.rakuten.co.jp/search/mall/switch+lite/?s=2')チェックボックスを操作

画面左側の「送料無料」のチェックボックスにチェックを入れたいと思います。

その場合はいつも通り要素を確認し、末尾にclick()を記載します。driver.find_element_by_name('f').click()チェックが付いた状態で再度上記を実行するとエラーになります。

そのため以下のようにしても良いと思います。try: driver.find_element_by_name('f').click() except: print('checked')前のページに戻る・先のページに進む

driver.back() # 前のページに戻る driver.forward() # 先のページに進むURLの取得

現在表示しているページのURLを取得できます。

driver.current_urlページタイトルの取得

現在表示しているページのタイトルを取得できます。

driver.titleマウス操作をする

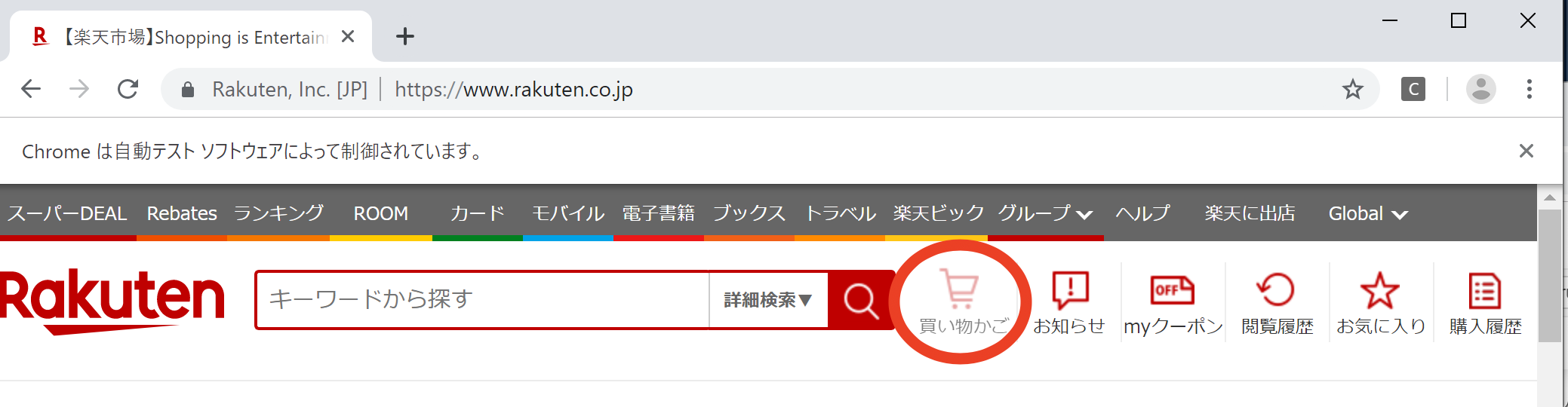

画面上部の「買い物かご」にマウスカーソルを合わせてみようと思います。

まずいつも通り「買い物かご」の要素を確認するとclass=basket-linkでした。

この情報を用いて以下のように記載して実行します。from selenium.webdriver.common.action_chains import ActionChains driver = webdriver.Chrome() driver.get("https://rakuten.co.jp") actions = ActionChains(driver) actions.move_to_element( driver.find_element_by_class_name("basket-link") ).perform()すると「買い物かご」の部分が色が薄くなっていると思います。

自分でマウスカーソルをいじってみるとわかりますが、「買い物かご」の上にマウスカーソルをあてると色が薄くなります。

マウスカーソルは表示されないですが、カーソルがあたった時と同じ動作になっていることがわかります。スクリーンショットを撮る

同じフォルダにスクリーンショットが保存されます。

driver.save_screenshot('test.png')画面をスクロールする

driver.execute_script("window.scrollTo(0, 1000);")DoS攻撃と間違われないようにするために

サイトに負荷を与えないように、またDoS攻撃と間違われないようにするために、処理の途中にsleepをはさむのも良いと思います。

from selenium import webdriver import time driver = webdriver.Chrome() driver.get("https://rakuten.co.jp") time.sleep(5) driver.find_element_by_class_name('searchInput').send_keys('switch lite') time.sleep(5) driver.find_element_by_class_name('searchBtn').click()ブラウザを閉じる

driver.quit()

- 投稿日:2019-09-09T20:46:26+09:00

jsonスキーマの色々な機能を使用する

はじめに

pythonでjsonスキーマを使用するでは、jsonスキーマの簡単な使用方法をまとめました。

jsonスキーマには、さらに色々な機能がありますが、あまり知られていないためまとめようと思います。そのため、ここにまとめてあるのはjsonスキーマでチェックできる型や上限など良く知られているものは省略しています。環境

- python:3.6.5

- jsonschema:3.0.1

値チェックの色々

複数値内で値が合致しているものがあるかチェックする

入力値があらかじめ決まっている場合に

enumに設定してあげることで設定した値が入力されたらOK、入力された値が設定外ならエラーになります。schema.json{ "$schema": "http://json-schema.org/draft-07/schema#", "title": "PyJsonValidate", "description": "sample json for json validate", "type": "object", "properties" :{ "kind": { "type": "string", "enum": [ "dog", "cat" ] } } }サンプル用のpython

json_schema_main.pyimport json from jsonschema import validate, ValidationError with open('schema.json') as file_obj: json_schema = json.load(file_obj) item = { "kind": "mouse", } try: validate(item, json_schema) except ValidationError as e: print(e.message) print('END')結果

'mouse' is not one of ['dog', 'cat'] ENDjsonスキーマでkindキーの値はdog、catだと指定しているため、mouseを入力するとエラーして、mouseはdogでもcatでもないという旨のメッセージが表示されました。

同一キーで複数のチェックパターンを設定する

あまり仕様的に褒められたものではないですが、同じキーを再利用して全く別の値を入力することがあります。その際に、

anyOfを使用すると同じキーでありながら別パターンのチェックをすることができます。schema.json{ "$schema": "http://json-schema.org/draft-07/schema#", "title": "PyJsonValidate", "description": "sample json for json validate", "type": "object", "properties": { "kind": { "anyOf": [ {"type": "string"}, {"type": "integer"} ] } } }サンプル用のpythonは上と同じです。

itemの値だけ変更しています。結果

0.01 is not of type 'string' ENDjsonスキーマでkindキーの値は文字列と整数と指定しているため、0.01を入力するとエラーしました。また、当然ですが文字列と整数を入力した場合はエラーせずに終了しました。

今回は型の指定のみしましたが{}内に上限値など他の設定を入れるとその設定もそれぞれに有効になります。複数パターンのキーをチェックする

anyOfの応用です。これもあまり仕様的に褒められたものではないですが、場合によって入力されるキーのパターンが複数ある場合にも

anyOfを使うことでチェックできます。schema.json{ "$schema": "http://json-schema.org/draft-07/schema#", "title": "PyJsonValidate", "description": "sample json for json validate", "type": "object", "anyOf":[ {"additionalProperties": false, "properties":{"cat": {"type": "string"}}}, {"additionalProperties": false, "properties":{"dog": {"type": "string"}}} ] }サンプル用のpythonは上と同じです。

itemの値だけ変更しています。結果

Additional properties are not allowed ('mouse' was unexpected) ENDjsonスキーマでキーがcatまたはdogと指定しているため、itemのキーをmouseにして入力するとエラーしました。また、当然ですがdogとcatのキーを入力した場合はエラーせずに終了しました。

あるパターンのキーをチェックする

キーとキーの間の整合性を取るために2つのうちどちらかのキーのみ入力してほしい場合があります。その場合には

oneOfを使うことでチェックできます。schema.json{ "$schema": "http://json-schema.org/draft-07/schema#", "title": "PyJsonValidate", "description": "sample json for json validate", "type": "object", "oneOf":[ {"additionalProperties": false, "properties":{"cat": {"type": "string"}}}, {"additionalProperties": false, "properties":{"dog": {"type": "string"}}} ] }サンプル用のpythonは上と同じです。

itemの値だけ変更しています。json_schema_main.pyitem = { "dog": "pochi", "cat": "tama" }結果

Additional properties are not allowed ('dog' was unexpected) END正常パターン

json_schema_main.pyitem = { "dog": "pochi" }結果

ENDjsonスキーマでキーがcatとdogのパターンを禁止しているため、itemにdogとcatを入力するとエラーしました。また、当然ですがcatのキーだけを入力した場合はエラーせずに終了しました。anyOfと同様にこれも様々な設定をできます。

指定した以外の値を受け取る

ある値以外を欲しいという場合に

allOfとnotを使用してチェックできます。schema.json{ "$schema": "http://json-schema.org/draft-07/schema#", "title": "PyJsonValidate", "description": "sample json for json validate", "type": "object", "properties":{ "dog": { "allOf": [ {"type": "string"}, {"not": {"enum": ["pochi", "tama"]}} ] } } }サンプル用のpythonは上と同じです。

itemの値だけ変更しています。json_schema_main.pyitem = { "dog": "pochi" }結果

{'enum': ['pochi', 'tama']} is not allowed for 'pochi' END正常パターン

json_schema_main.pyitem = { "dog": "tibi" }結果

ENDenumでpochiとtamaだけの設定をnotで反転させ、pochiとtamaは受け付けないようにしました。また、allOfを使用して文字列と値の指定両方を満たすようにチェックしています。特にallOfを使用する必要はありませんが丁度良かったので使いました。

jsonスキーマの表記の色々

設定をリンクで指定する

設定が複雑になっていくと設定だけ別ファイルや別ブロックにまとめたい場合があります。その場合は、

$refに指定してあげることでリンクすることができます。schema.json{ "$schema": "http://json-schema.org/draft-07/schema#", "title": "PyJsonValidate", "description": "sample json for json validate", "type": "object", "$ref": "#/definitions/dog", "definitions": { "dog": { "properties" :{ "kind": { "type": "string", "enum": ["dog"] } } } } }item = { "kind": "cat", }結果

'cat' is not one of ['dog'] ENDrefで指定したdefinitions/dogの設定が反映されました。

上記例はあまり見やすくなった気がしないですが、anyOfやoneOfなど複雑になっていくとこの設定があるかないかで大きく見やすさが変わります。設定を別ファイルに分ける

次は別ファイルに分けていきます。json側では

$refにファイル名を指定してあげて、python側の設定で別ファイルのリンクを設定してあげます。

python側の設定はjsonschemaのライブラリのRefResolverクラスに設定ファイルがあるディレクトリと元のjsonスキーマを渡してあげてvalidate時に指定してあげる必要があります。schema.json{ "$schema": "http://json-schema.org/draft-07/schema#", "title": "PyJsonValidate", "description": "sample json for json validate", "type": "object", "$ref": "dog.json" }dog.json{ "properties" :{ "kind": { "type": "string", "enum": ["dog"] } } }json_schema_main.pyimport os import json from jsonschema import validate, ValidationError, RefResolver with open('schema.json') as file_obj: json_schema = json.load(file_obj) item = { "kind": "cat", } try: schema_path = 'file:///{0}/'.format((os.getcwd()).replace("\\", "/")) ref = RefResolver(schema_path, json_schema) validate(item, json_schema, resolver=ref) except ValidationError as e: print(e.message) print('END')結果

'cat' is not one of ['dog'] ENDjsonschemaライブラリの使い方が少しネックですが、jsonファイルはとても分かりやすくなりました。今回は設定まるまる別ファイルにしましたがやろうと思えばどんな設定も分けられるため、ルールを決めてファイル分けすると見やすくなるのではないかと思います。

おわりに

jsonスキーマの色々な使い方についてまとめました。おそらく、頭を使えばほとんどの入力値チェックがjsonスキーマで可能なほど汎用性のあるものでした。

ただ、ここまでやってしまうと人が見てわかりやすいjsonという利点をつぶしてしまいそうなので個人的にはよっぽどの理由がない限りは単純なjsonを使用しています。

開発の時に他の人の技術レベルを考えて開発していますが、技術レベルと開発のレベルはトレードオフの関係なので、どのレベルに抑えるのかがすごい悩みます。

- 投稿日:2019-09-09T20:46:26+09:00

jsonスキーマを色々な機能を使用する

はじめに

pythonでjsonスキーマを使用するでは、jsonスキーマの簡単な使用方法をまとめました。

jsonスキーマには、さらに色々な機能がありますが、あまり知られていないためまとめようと思います。そのため、ここにまとめてあるのはjsonスキーマでチェックできる型や上限など良く知られているものは省略しています。環境

- python:3.6.5

- jsonschema:3.0.1

値チェックの色々

複数値内で値が合致しているものがあるかチェックする

入力値があらかじめ決まっている場合に

enumに設定してあげることで設定した値が入力されたらOK、入力された値が設定外ならエラーになります。schema.json{ "$schema": "http://json-schema.org/draft-07/schema#", "title": "PyJsonValidate", "description": "sample json for json validate", "type": "object", "properties" :{ "kind": { "type": "string", "enum": [ "dog", "cat" ] } } }サンプル用のpython

json_schema_main.pyimport json from jsonschema import validate, ValidationError with open('schema.json') as file_obj: json_schema = json.load(file_obj) item = { "kind": "mouse", } try: validate(item, json_schema) except ValidationError as e: print(e.message) print('END')結果

'mouse' is not one of ['dog', 'cat'] ENDjsonスキーマでkindキーの値はdog、catだと指定しているため、mouseを入力するとエラーして、mouseはdogでもcatでもないという旨のメッセージが表示されました。

同一キーで複数のチェックパターンを設定する

あまり仕様的に褒められたものではないですが、同じキーを再利用して全く別の値を入力することがあります。その際に、

anyOfを使用すると同じキーでありながら別パターンのチェックをすることができます。schema.json{ "$schema": "http://json-schema.org/draft-07/schema#", "title": "PyJsonValidate", "description": "sample json for json validate", "type": "object", "properties": { "kind": { "anyOf": [ {"type": "string"}, {"type": "integer"} ] } } }サンプル用のpythonは上と同じです。

itemの値だけ変更しています。結果

0.01 is not of type 'string' ENDjsonスキーマでkindキーの値は文字列と整数と指定しているため、0.01を入力するとエラーしました。また、当然ですが文字列と整数を入力した場合はエラーせずに終了しました。

今回は型の指定のみしましたが{}内に上限値など他の設定を入れるとその設定もそれぞれに有効になります。複数パターンのキーをチェックする

anyOfの応用です。これもあまり仕様的に褒められたものではないですが、場合によって入力されるキーのパターンが複数ある場合にも

anyOfを使うことでチェックできます。schema.json{ "$schema": "http://json-schema.org/draft-07/schema#", "title": "PyJsonValidate", "description": "sample json for json validate", "type": "object", "anyOf":[ {"additionalProperties": false, "properties":{"cat": {"type": "string"}}}, {"additionalProperties": false, "properties":{"dog": {"type": "string"}}} ] }サンプル用のpythonは上と同じです。

itemの値だけ変更しています。結果

Additional properties are not allowed ('mouse' was unexpected) ENDjsonスキーマでキーがcatまたはdogと指定しているため、itemのキーをmouseにして入力するとエラーしました。また、当然ですがdogとcatのキーを入力した場合はエラーせずに終了しました。

あるパターンのキーをチェックする

キーとキーの間の整合性を取るために2つのうちどちらかのキーのみ入力してほしい場合があります。その場合には

oneOfを使うことでチェックできます。schema.json{ "$schema": "http://json-schema.org/draft-07/schema#", "title": "PyJsonValidate", "description": "sample json for json validate", "type": "object", "oneOf":[ {"additionalProperties": false, "properties":{"cat": {"type": "string"}}}, {"additionalProperties": false, "properties":{"dog": {"type": "string"}}} ] }サンプル用のpythonは上と同じです。

itemの値だけ変更しています。json_schema_main.pyitem = { "dog": "pochi", "cat": "tama" }結果

Additional properties are not allowed ('dog' was unexpected) END正常パターン

json_schema_main.pyitem = { "dog": "pochi" }結果

ENDjsonスキーマでキーがcatとdogのパターンを禁止しているため、itemにdogとcatを入力するとエラーしました。また、当然ですがcatのキーだけを入力した場合はエラーせずに終了しました。anyOfと同様にこれも様々な設定をできます。

指定した以外の値を受け取る

ある値以外を欲しいという場合に

allOfとnotを使用してチェックできます。schema.json{ "$schema": "http://json-schema.org/draft-07/schema#", "title": "PyJsonValidate", "description": "sample json for json validate", "type": "object", "properties":{ "dog": { "allOf": [ {"type": "string"}, {"not": {"enum": ["pochi", "tama"]}} ] } } }サンプル用のpythonは上と同じです。

itemの値だけ変更しています。json_schema_main.pyitem = { "dog": "pochi" }結果

{'enum': ['pochi', 'tama']} is not allowed for 'pochi' END正常パターン

json_schema_main.pyitem = { "dog": "tibi" }結果

ENDenumでpochiとtamaだけの設定をnotで反転させ、pochiとtamaは受け付けないようにしました。また、allOfを使用して文字列と値の指定両方を満たすようにチェックしています。特にallOfを使用する必要はありませんが丁度良かったので使いました。

jsonスキーマの表記の色々

設定をリンクで指定する

設定が複雑になっていくと設定だけ別ファイルや別ブロックにまとめたい場合があります。その場合は、

$refに指定してあげることでリンクすることができます。schema.json{ "$schema": "http://json-schema.org/draft-07/schema#", "title": "PyJsonValidate", "description": "sample json for json validate", "type": "object", "$ref": "#/definitions/dog", "definitions": { "dog": { "properties" :{ "kind": { "type": "string", "enum": ["dog"] } } } } }item = { "kind": "cat", }結果

'cat' is not one of ['dog'] ENDrefで指定したdefinitions/dogの設定が反映されました。

上記例はあまり見やすくなった気がしないですが、anyOfやoneOfなど複雑になっていくとこの設定があるかないかで大きく見やすさが変わります。設定を別ファイルに分ける

次は別ファイルに分けていきます。json側では

$refにファイル名を指定してあげて、python側の設定で別ファイルのリンクを設定してあげます。

python側の設定はjsonschemaのライブラリのRefResolverクラスに設定ファイルがあるディレクトリと元のjsonスキーマを渡してあげてvalidate時に指定してあげる必要があります。schema.json{ "$schema": "http://json-schema.org/draft-07/schema#", "title": "PyJsonValidate", "description": "sample json for json validate", "type": "object", "$ref": "dog.json" }dog.json{ "properties" :{ "kind": { "type": "string", "enum": ["dog"] } } }json_schema_main.pyimport os import json from jsonschema import validate, ValidationError, RefResolver with open('schema.json') as file_obj: json_schema = json.load(file_obj) item = { "kind": "cat", } try: schema_path = 'file:///{0}/'.format((os.getcwd()).replace("\\", "/")) ref = RefResolver(schema_path, json_schema) validate(item, json_schema, resolver=ref) except ValidationError as e: print(e.message) print('END')結果

'cat' is not one of ['dog'] ENDjsonschemaライブラリの使い方が少しネックですが、jsonファイルはとても分かりやすくなりました。今回は設定まるまる別ファイルにしましたがやろうと思えばどんな設定も分けられるため、ルールを決めてファイル分けすると見やすくなるのではないかと思います。

おわりに

jsonスキーマの色々な使い方についてまとめました。おそらく、頭を使えばほとんどの入力値チェックがjsonスキーマで可能なほど汎用性のあるものでした。

ただ、ここまでやってしまうと人が見てわかりやすいjsonという利点をつぶしてしまいそうなので個人的にはよっぽどの理由がない限りは単純なjsonを使用しています。

開発の時に他の人の技術レベルを考えて開発していますが、技術レベルと開発のレベルはトレードオフの関係なので、どのレベルに抑えるのかがすごい悩みます。

- 投稿日:2019-09-09T19:43:48+09:00

Project Euler 010を解いてみる。

Project Euler 010

10以下の素数の和は 2 + 3 + 5 + 7 = 17 である.

200万以下の全ての素数の和を求めよ.->[次の問題]

考え方

シンプルな問題ですね。

エラトステネスの篩で200万以下の素数を計算して合計すれば良さそうです。

篩のプログラムは以前に作ってmath_functions.pyに入れてあるのを使います。

なにかに応用できるかなと思ってboolean配列で返す関数と素数列で返す関数に分けてあります。

配列の数字を付け加えたり消したりといった処理やifによる分岐は重くなるようなので、boolean配列のTrue, Falseを切り替えることで値を表し、最後に数列に変換しています。

また、2,3以外の素数は6k±1であるので、少し探索範囲を減らしています。boolean_arr[4::2] = False #これはboolean_arrインデックス4から2個ずつ(4,6,8,...)をFalseにするという処理。 #bookean_arr[i*2::i] = Falseとすることでiより大きいiの倍数のインデックスをFalseにできる=非素数を消せる #if文を使わないので多分早いコード

math_functions.pyimport numpy as np def get_prime_arr_bool(n: int) -> np.ndarray: """ 自然数n未満の素数をboolean配列で返す関数 2,3,5 -> [False, False, True, True, False, True] :param n: int :return: numpy.ndarray """ boolean_arr = np.ones((n,), dtype=np.bool) # n個の要素をもつのboolean配列(0~n-1に対応)を生成、全てTrueとする boolean_arr[0:2] = False # [0,1]をFalseとする boolean_arr[4::2] = False # 2以外の偶数をFalseとする boolean_arr[6::3] = False # 3以外の3の倍数をFalseとする for i in range(5, ceil(sqrt(n)), 6): # iは初項5、公差6の等差数列とする if boolean_arr[i]: # 6k-1に対応。iに一致する要素がTrue=素数のとき boolean_arr[i * 2::i] = False # iの倍数の要素(非素数)をFalseとする if boolean_arr[i + 2]: # 6k+1に対応。 boolean_arr[(i + 2) * 2::(i + 2)] = False return boolean_arr # boolean配列を返す def get_prime_arr(n: int) -> np.ndarray: """ 自然数n未満の素数の配列を返す関数 :param n: int :return: numpy.ndarray """ return np.arange(n)[get_prime_arr_bool(n)] # 0~n-1の配列を生成、boolean配列でTrueとなっている数のみを返すeuler010.pyimport numpy as np from math_functions import get_prime_arr def main(): n = 200 * 10000 prime_arr = get_prime_arr(n+1) # 素数配列を生成(n未満を生成なので一応+1しておく) print(np.sum(prime_arr)) # 合計 if __name__ == '__main__': main()

結果

142913828922

main処理時間: 0.020266056060791016 sec.

できればforループの中のifもなくしたいところですが、どうやったらifなしで実現できるのか思いつかないので現状はこれが精一杯です。

- 投稿日:2019-09-09T19:43:48+09:00

Project Euler 010を解いてみる。「素数の和」

Project Euler 010

10以下の素数の和は 2 + 3 + 5 + 7 = 17 である.

200万以下の全ての素数の和を求めよ.->[次の問題]

Sympyにありました。

n = 200 * 10000 # sympy.primerange(a, b)でa以上b未満の素数を生成するgeneratorを返す prime_generator = sympy.primerange(2,n+1) print(sum(prime_generator))ただ、この書き方だと下記のエラトステネスの篩のほうが早いです。

考え方

シンプルな問題ですね。

エラトステネスの篩で200万以下の素数を計算して合計すれば良さそうです。

篩のプログラムは以前に作ってmath_functions.pyに入れてあるのを使います。

なにかに応用できるかなと思ってboolean配列で返す関数と素数列で返す関数に分けてあります。

配列の数字を付け加えたり消したりといった処理やifによる分岐は重くなるようなので、boolean配列のTrue, Falseを切り替えることで値を表し、最後に数列に変換しています。

また、2,3以外の素数は6k±1であるので、少し探索範囲を減らしています。boolean_arr[4::2] = False #これはboolean_arrインデックス4から2個ずつ(4,6,8,...)をFalseにするという処理。 #bookean_arr[i*2::i] = Falseとすることでiより大きいiの倍数のインデックスをFalseにできる=非素数を消せる #if文を使わないので多分早いコード

math_functions.pyimport numpy as np def get_prime_arr_bool(n: int) -> np.ndarray: """ 自然数n未満の素数をboolean配列で返す関数 2,3,5 -> [False, False, True, True, False, True] :param n: int :return: numpy.ndarray """ boolean_arr = np.ones((n,), dtype=np.bool) # n個の要素をもつのboolean配列(0~n-1に対応)を生成、全てTrueとする boolean_arr[0:2] = False # [0,1]をFalseとする boolean_arr[4::2] = False # 2以外の偶数をFalseとする boolean_arr[6::3] = False # 3以外の3の倍数をFalseとする for i in range(5, ceil(sqrt(n)), 6): # iは初項5、公差6の等差数列とする if boolean_arr[i]: # 6k-1に対応。iに一致する要素がTrue=素数のとき boolean_arr[i * 2::i] = False # iの倍数の要素(非素数)をFalseとする if boolean_arr[i + 2]: # 6k+1に対応。 boolean_arr[(i + 2) * 2::(i + 2)] = False return boolean_arr # boolean配列を返す def get_prime_arr(n: int) -> np.ndarray: """ 自然数n未満の素数の配列を返す関数 :param n: int :return: numpy.ndarray """ return np.arange(n)[get_prime_arr_bool(n)] # 0~n-1の配列を生成、boolean配列でTrueとなっている数のみを返すeuler010.pyimport numpy as np from math_functions import get_prime_arr def main(): n = 200 * 10000 prime_arr = get_prime_arr(n+1) # 素数配列を生成(n未満を生成なので一応+1しておく) print(np.sum(prime_arr)) # 合計 if __name__ == '__main__': main()

結果

142913828922

main処理時間: 0.020266056060791016 sec.

できればforループの中のifもなくしたいところですが、どうやったらifなしで実現できるのか思いつかないので現状はこれが精一杯です。

- 投稿日:2019-09-09T19:15:11+09:00

Anacondaと付き合うための情報を整理する(Pythonのインストール方法とパッケージ管理方法を中心に)

はじめに

PyCon JP 2019で「Anaconda環境運用TIPS」という15分のトークをします。

ドキュメントを当たったり、Anacondaの環境で実験したりして得た知見全てを15分のトークに収めることが難しかったので、別途記事にすることにしました。

正確性を重視したいので、誤った記載を見つけた場合は、コメントなどでご指摘いただけるとありがたいです。前提

この記事で扱うこと

- Pythonのインストール方法(Anaconda中心)

- AnacondaでPythonをインストールした場合のパッケージ管理方法の特徴

扱わないこと

- パッケージとは

- Anacondaの環境(base環境とは)

- condaコマンドの詳細な使い方(特に環境を分離する方法)

今後の更新や別記事でアップデート予定です。

おことわり

この記事を書く意図は、Anacondaをオススメすることではありません。

自分の中に蓄積されたAnacondaに関係する情報の整理が目的です。また、書き手はPythonを使った開発でAnacondaを使っているわけではありません。

Pythonを教える中で、Anaconda環境の問題を何件か解決し、この記事に記載した認識に至りました。

(誤りがあるかもしれませんので、お気づきの点はお知らせください)動作確認環境

- macOS 10.12.6

- conda 4.6.11

一部の検証にDockerイメージも使っています。

Pythonのインストール方法

Pythonには複数のインストール方法があります。

どういった方法があり、それぞれどのくらいの人が使っているかは、例えば、JetBrainsが調査したPython Developers Survey 2018 Resultsがあります(Python Installation and Upgradeという項目1)。

- 1位はOSごとに提供される方法(

apt-get,yum,brewなど)で38%- 2位はPython.orgで33%

- 3位がAnacondaで22%

また、2019年4月に「みんなのPython勉強会」で環境構築について話した際に参加者に挙手していただいたところ、AnacondaでPythonをインストールした方が半数で、Python.orgからインストールした方よりも多かったと記憶しています。

というわけで、ここでは、Pythonをインストールする際に、Anacondaという選択肢を選ぶ人が増えていることを確認しました。2

AnacondaでPythonをインストールする際の特徴

では、AnacondaでPythonをインストールした場合、他の方法と何が違うのでしょうか。

大きな特徴は、Pythonをインストールするだけでなく、科学計算に使うパッケージも合わせてインストールする3ということです。

Python.orgやbrewやaptでPythonをインストールする場合、科学計算に使うパッケージを別途インストールする必要があります。科学計算に使うパッケージ(numpy, scipy, pandas)が合わせてインストールされている例を見てみましょう。

AnacondaをインストールしたmacOSのターミナルでPythonを対話モードで起動します。(base) $ python Python 3.7.3 (default, Mar 27 2019, 16:54:48) [Clang 4.0.1 (tags/RELEASE_401/final)] :: Anaconda, Inc. on darwin Type "help", "copyright", "credits" or "license" for more information. >>> import numpy, scipy, pandas >>>科学計算のパッケージに関連して、Anacondaでは機械学習のパッケージ(例:tensorflow)もインストールしやすいという特徴があります。

(macOSやLinuxを使った経験では、Python.orgからインストールしたPythonでも環境構築できました。私が未経験のWindowsでは苦労があるのかもしれません)他の特徴として、Anacondaはクロスプラットフォームであり、Windows・macOS・Linuxいずれでも動作する4という点も挙げられます。

これはbrewやaptなどOSごとに提供される方法でPythonをインストールする選択肢とは対照的ですね。

condaコマンドAnacondaにおけるパッケージ管理は

condaというコマンドで行われます。

AnacondaにおいてはPythonもパッケージとして扱われるため、Pythonのバージョンも管理5できます(脚注4のリンク参照)。AnacondaでPythonを導入するとbaseという名前の環境ができます。

そこに含まれるパッケージの一覧をconda listで表示してみましょう。(base) $ conda list # Name Version Build Channel numpy 1.16.2 py37hacdab7b_0 pandas 0.24.2 py37h0a44026_0 python 3.7.3 h359304d_0 scipy 1.2.1 py37h1410ff5_0200行を超える出力があるため、上では一部を抜粋しました。

AnacondaでPythonをインストールすると、200を超えるパッケージもすぐに使える状態というわけです。Anacondaを使わずにPythonをインストールした場合、

condaコマンドは使えず、pipというコマンドでパッケージを管理します。

混乱を招きやすいのですが、pipコマンドはAnacondaでも使うことができます(この点については理解して使っていただきたいため、詳細を後述します)

condapipAnaconda ◯(オススメしたい) △(使える) Anaconda以外 ☓(使えない) ◯(オススメしたい) なぜAnacondaが登場したか

Anacondaが登場した背景として、科学計算に用いるパッケージにはバイナリモジュールに依存するものがあり、

pipコマンドでインストールすることが難しい6ことがあったそうです。

このあたりの状況は改善してきている7と認識していますが、科学計算のパッケージのインストールのしにくさという問題により、今後もAnacondaは1つの選択肢として残り続けるのではないかと私自身は考えています。

condaとpipの違い上では

condaではPythonのバージョンを管理できるが、pipではできないという違いを見ました。

実はこの点よりも重要な違いがあります。

それは、配布されたパッケージをインストールする際の参照先のサイト(リポジトリ)が異なるということです。

condaでもpipでも、配布されたパッケージ(アーカイブされたファイル)をインターネット経由でダウンロードし、手元の環境にインストールします8。

pipでパッケージをインストールする場合は、デフォルトでPyPI(Python Package Index)にあるパッケージを参照します。

一方、condaでパッケージをインストールする場合、デフォルトではAnaconda社が管理するリポジトリ(repo.anaconda.com)を参照します9。PyPIは開発者に公開されており、誰でもPythonのパッケージを配布するために利用できます。

そのため、大量の多岐に渡るパッケージが集まっています。一方、Anaconda社のリポジトリは、開発者に公開されているわけではありません。

Anaconda社が管理しているため、PyPIに比べてパッケージはずっと少ないです。

また、PyPIにある最新版が必ずあるとは限りません。

この点への対応として、コミュニティが運営するconda-forgeなどのリポジトリからcondaコマンドでパッケージをインストールする方法が案内されています10。ここまで、

condaの場合もpipの場合もパッケージという同じ言葉を使ってきましたが、実はcondaとpipとでパッケージの形式は異なります11。

condaとpipは混ぜられる?Anacondaは導入がしやすい反面、パッケージのリポジトリという点でやや苦労するという印象を私は持っています。

対応として、conda-forgeを紹介しましたが、condaコマンドのドキュメントでは、conda-forgeで対応できない場合、pipを

使うことが案内されています12。この記載を見て、「condaとpip:混ぜるな危険」という2018年2月のエントリを思い出す方もいるでしょう。

「condaとpipを混ぜていいの?」と。ドキュメントの記載によれば、

condaの4.6以降ではcondaとpipが混ぜられる13ようです。

しかしながら、環境によっては壊れてしまうこともあるようなので、この記事の初公開の段階では積極的にオススメはしません。

(このあたり登壇当日までに結論を出し、アップデートします)(前略) conda now understands pip metadata more intelligently.

(注)リンク先には以下の2つが記載されており、ここで紹介しているのは後者の方です。

- experimentalな機能:

.condarc(condaの設定ファイルの編集)condaがpipのメタデータに対応した話後述の実験結果から、後者の機能はexperimentalの機能とは別に有効になっていると考えています。

(注 終わり)

Dockerイメージcontinuumio/anaconda3のタグ2019.07を用いて実験してみました。

- base環境に入っていないtensorflowのバージョン1.13.1を

conda install tensorflow=1.13.1でインストールpip install -U tensorflowで最新のバージョン1.14.0にアップデート- 対話モードやJuputer Notebookでtensorflowがimportできることを確認

Dockerイメージを用いた検証では、無事importできました。

しかしながら、macOSにてbaseと同様の環境を作って検証をしたところ、3に失敗する結果となりました。

(「Illegal instruction: 4」と表示されて対話モードが終了します。JuputerではKernelがRestartします)ドキュメント上は

condaとpipが混ぜられると記載されていますが、混ぜることで環境を壊さない可能性が絶対にないとは言えないという認識でいます。

そこで、Anacondaを使っている場合のパッケージ管理(暫定版)は

- まずAnaconda社のリポジトリやconda-forgeを検索

- 1で見つからない場合は、リスク承知でPyPIからインストール

という手順になりそうです。

そして、Anaconda社のリポジトリやconda-forgeからインストールしたパッケージのアップデートはcondaコマンドを使うことで、環境を壊すリスクは低減されると考えています。環境が壊れるリスクを抑える別の方法としては、Anacondaの環境を開発ごとに分離して使うことを私はオススメしたいです。

分離してあれば、ある環境が壊れたとしてもAnaconda自体の再インストールは発生しないと考えています。Anacondaを使った場合の環境の切り分けについては、PyCon JP当日のトーク(または別の記事で)お伝えします。

%の合計が100を超えるので、複数回答と考えています ↩

この理由について、JetBrainsの調査は「Pythonを使う他の種類の開発よりもデータサイエンスの人気が増していることを示している」と述べています。また、私の推測ですが、国内では毎月のように機械学習の入門書(やPythonの入門書)が刊行されており、そこでAnacondaが紹介されることが多いという理由もありそうです。後の節で触れますが、インストールする手順が簡単というのは著者にとって魅力なのでしょう。 ↩

https://docs.python.org/ja/3/using/windows.html#alternative-bundles ↩

https://packaging.python.org/guides/installing-scientific-packages/#the-conda-cross-platform-package-manager ↩

Pythonのバージョン管理は後述の

pipではできません ↩https://docs.python.org/ja/3/installing/index.html#install-scientific-python-packages ↩

numpy 1.10.4やscipy1.0.0以降はメジャーなOS向けにwheelフォーマットでパッケージがリリースされているそうですが、Windowsでは最適化された線形代数演算の性能が出ない可能性があるそうです ref:https://packaging.python.org/guides/installing-scientific-packages/ ↩

Distribution Packageの用語説明をもとにしています ↩

https://docs.conda.io/projects/conda/en/latest/user-guide/concepts/channels.html (ドキュメント上ではリポジトリのことをチャンネルと呼んでいるようです) ↩

ref:

condaで扱うパッケージ、pipで扱うパッケージ ↩https://docs.conda.io/projects/conda/en/latest/user-guide/concepts/channels.html#conda-channels ↩

https://docs.conda.io/projects/conda/en/latest/user-guide/configuration/pip-interoperability.html ↩

- 投稿日:2019-09-09T18:33:14+09:00

pythonで遊んだ

遊びました。Python歴2時間くらいです。

環境構築

Pythonは Colabというサービスを使えばブラウザ上でも簡単に動かすことができるようですが今回はちゃんと環境構築からします。

こちらのサイトを参考にさせて頂きました。

Pythonの開発環境を用意しよう!(Mac)まずはHomebrewをインストールします。

/usr/bin/ruby -e "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install)"インストールできたらHomebrewのコマンドを使ってpyenvをインストールします。

brew install pyenv「.bash_profile」ファイルに設定用のコードを追加します。

echo 'export PYENV_ROOT="$HOME/.pyenv"' >> ~/.bash_profile echo 'export PATH="$PYENV_ROOT/bin:$PATH"' >> ~/.bash_profile echo 'eval "$(pyenv init -)"' >> ~/.bash_profile touch ~/.profileこれでpyenvコマンドが使えるようになったので

pyenv install --listで、最新のPythonのバージョンを確認して、インストールします。

pyenv install 3.XX.XX (使用するバージョンを入力する)最後に

pyenv global 3.XX.XXで先程インストールしたバージョンのPythonを使うようにします。

これで環境構築は終了です。

拡張子が.pyのファイルを作成してVSCodeなどで開いてみましょう。なお、コードを実行する方法はターミナルで

python XXXXX.py (ファイル名)です

あそぶ

環境ができたので適当にコードを書いてみます。

今回はPythonの機能の一つである辞書を使ってみました。dics = {'りんご': 'Apple', 'オレンジ': 'Orange'}辞書はこのように記述すれば作成することができるようです。

valuesの方にまた新たに辞書を指定してどんどん入れ子の形にすることも可能です。dics = { 'りんご': { '色': '赤', '形': '丸' }, 'オレンジ': 'Orange' }この機能を使って簡単なゲームを作ってみます。

問診を行って腹痛を訴える患者の病気を特定するゲームです。stomachache = { '腹膜炎': { 1: '今朝からです。', 2: 'お腹が全体てきに痛いです。', 3: '下痢はしていませんが、嘔吐しています。' }, '胃腸炎': { 1: '朝起きてからずっとです。', 2: '下の方、腸のあたりです。', 3: 'はい、しています。吐き気もあります。' }, '肺炎': { 1: '一昨日の夜からです。', 2: '上の方です。', 3: 'していません。少し熱っぽい気がします。' }, 'ストレス': { 1: 'もう何ヶ月も前からです。', 2: 'わからないです。胃のあたりな気がします。', 3: '偶にします。' } }このような感じで辞書を作成しました。

私は医者ではないので内容はかなり適当です。本気にしないでください。import random num = random.randint(0,3) lis = list(stomachache.values())import random num = random.randint(0,3) list = list(stomachache.values()) def question(): print('質問内容を選ぶ (1, 2 or 3)') print( '1: いつごろから痛みますか?\n2: どの辺りが痛みますか?\n3: 下痢はしていますか?') question = input('>> ') if question == '1': print(list(list[num].values())[0]) elif question == '2': print(list(list[num].values())[1]) elif question == '3': print(list(list[num].values())[2]) else: print("数字を選択して入力してください")0から3のランダムな数字を取得して、上で作成した辞書から質問部分のみをリスト化します。

プレイヤーに入力してもらった値を元に、listから患者の回答を表示します。print('病気を特定する (1, 2, 3 or 4)') print( '1: 腹膜炎\n2: 胃腸炎\n3: 肺炎\n4: ストレス') answer = input('>> ') if int(answer) == num + 1: print('正解です') else: print('不正解です')問診内容を元にプレイヤーに病名を特定させます。ランダムな数字は0..3なのでnumに+1しています。

最終的なコードはこのような形になりました。

import random stomachache = { '腹膜炎': { 1: '今朝からです。', 2: 'お腹が全体てきに痛いです。', 3: '下痢はしていませんが、嘔吐しています。' }, '胃腸炎': { 1: '朝起きてからずっとです。', 2: '下の方、腸のあたりです。', 3: 'はい、しています。吐き気もあります。' }, '肺炎': { 1: '一昨日の夜からです。', 2: '上の方です。', 3: 'していません。少し熱っぽい気がします。' }, 'ストレス': { 1: 'もう何ヶ月も前からです。', 2: 'わからないです。胃のあたりな気がします。', 3: '偶にします。' } } num = random.randint(0,3) lis = list(stomachache.values()) def question(): print('質問は二回までできます。質問内容を選ぶ (1, 2 or 3)') print( '1: いつごろから痛みますか?\n2: どの辺りが痛みますか?\n3: 下痢はしていますか?') question = input('>> ') if question == '1': print(list(lis[num].values())[0]) elif question == '2': print(list(lis[num].values())[1]) elif question == '3': print(list(lis[num].values())[2]) else: print("数字を選択して入力してください") question() question() print('病気を特定する (1, 2, 3 or 4)') print( '1: 腹膜炎\n2: 胃腸炎\n3: 肺炎\n4: ストレス') answer = input('>> ') if int(answer) == num + 1: print('正解です') else: print('不正解です')質問は二回までできます。質問内容を選ぶ (1, 2 or 3) 1: いつごろから痛みますか? 2: どの辺りが痛みますか? 3: 下痢はしていますか? >> 1 今朝からです。 質問は二回までできます。質問内容を選ぶ (1, 2 or 3) 1: いつごろから痛みますか? 2: どの辺りが痛みますか? 3: 下痢はしていますか? >> 2 お腹が全体てきに痛いです。 病気を特定する (1, 2, 3 or 4) 1: 腹膜炎 2: 胃腸炎 3: 肺炎 4: ストレス >> 1 正解ですもう少し細部をこだわればもっとまともな問診ゲームが作れそう。

- 投稿日:2019-09-09T18:21:37+09:00

Pythonではじめる機械学習 データ表現と特徴量エンジニアリング(交互作用・多項式)

学習内容の目次

データ表現と特徴量エンジニアリング

- 交互作用

- 多項式

要約

☆交互作用

- 線形モデルに特に有効で,交互作用特徴量加える方法

- 交互作用特徴量とは,ビンの指示子と元の特徴量の積

- 交互作用特徴量を加えることで,個々のビンがオフセットと傾きを持つ

交互作用特徴量を加える一連の流れ

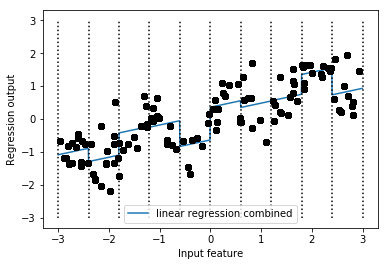

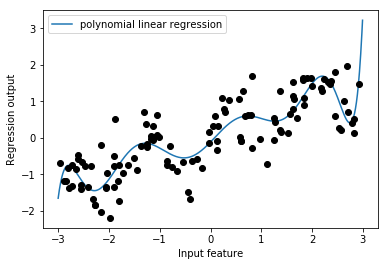

In[1]: # ビニングされたデータを適用した線形モデルに,元の特徴量(グラフのx軸)を加える X_combined = np.hstack([X, X_binned]) print(X_combined.shape) Out[1]: # 11次元のデータセットになる (120, 11) In[2]: # 11次元のデータを適用する reg = LinearRegression().fit(X_combined, y) line_combined = np.hstack([line, line_binned]) plt.plot(line, reg.predict(line_combined), label='linear regression combined') for bin in bins: plt.plot([bin, bin], [-3, 3], ':', c='k') plt.legend(loc="best") plt.ylabel("Regression output") plt.xlabel("Input feature") plt.plot(X[:, 0], y, 'o', c='k')

- 上の図は傾きが全てのビンで共有されている状態

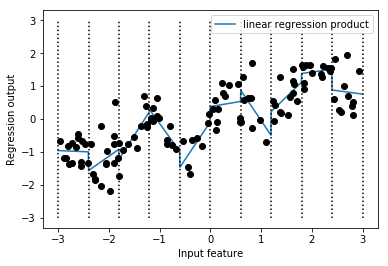

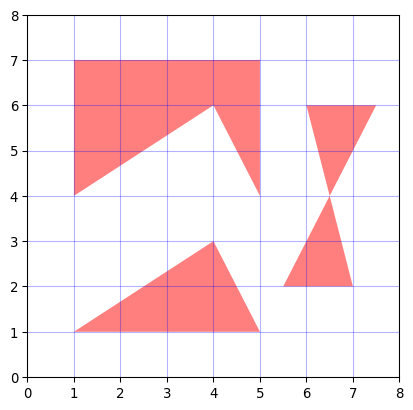

# 個々のビンが傾きを持つように,ビンと元の特徴量の積を求める In[3]: X_product = np.hstack([X_binned, X * X_binned]) print(X_product.shape) Out[3]: # 特徴量が20になることを確認 (120, 20) In[4]: reg = LinearRegression().fit(X_product, y) line_product = np.hstack([line_binned, line * line_binned]) plt.plot(line, reg.predict(line_product), label='linear regression product') for bin in bins: plt.plot([bin, bin], [-3, 3], ':', c='k') plt.plot(X[:, 0], y, 'o', c='k') plt.ylabel("Regression output") plt.xlabel("Input feature") plt.legend(loc="best")

- これによって個々のビンが傾きを持つ

☆多項式

- 線形モデルに特に有効で,多項式特徴量を加える方法

- 線形モデルのような単純なモデルには有効であるが,カーネル法を用いたSVMやランダムフォレストのような複雑なモデルには効果を発揮しない