- 投稿日:2019-07-11T23:30:31+09:00

言語処理100本ノックをNLP屋がやってみる: 第3章 20~29

はじめに

だいぶ間が空いてしまいました。お久しぶりです。

言語処理100本ノックの続き、今回は第3章をやっていきます。過去分はこちら↓

第1章 00~09 - 第2章 10~19Wikipediaの記事を以下のフォーマットで書き出したファイルjawiki-country.json.gzがある.

1行に1記事の情報がJSON形式で格納される

各行には記事名が"title"キーに,記事本文が"text"キーの辞書オブジェクトに格納され,そのオブジェクトがJSON形式で書き出される

ファイル全体はgzipで圧縮される

以下の処理を行うプログラムを作成せよ.ということで、人類が手にした最強兵器、正規表現に入門する章です。

あと、gzipファイルを読み込んだりjsonを読み込んだりすることに慣れていきます。

題材のgzファイルは本家から落とせますので手元にご用意を。20. JSONデータの読み込み

Wikipedia記事のJSONファイルを読み込み,「イギリス」に関する記事本文を表示せよ.問題21-29では,ここで抽出した記事本文に対して実行せよ.

この章は doctest がちょっと書きづらいので、ターミナルで確認する形にしておきます。

読み込むフォーマットは上にも引用したとおり、{"title": "タイトル", "text": "本文"}という感じです。各行がこのフォーマットのjsonになっているファイルが、gzipで圧縮されているファイルです。これを読み込むコードはこんな感じ。nlp20.pyimport gzip import json import re # あとで使うのでimportしておきます def load_json_gz(filename): """ 指定されたファイルを読み込みます。 """ with gzip.open(filename, 'rt', encoding='utf-8') as f: return {item['title']: item['text'] for item in [json.loads(line) for line in f]} articles = load_json_gz('jawiki-country.json.gz') england = articles['イギリス'] print(england)

gzip.openを使うと、普通にファイルをopenするのと同じインターフェースで gz ファイルを読み込むことができます。楽ちん楽ちん。

各行をjsonとしてパースするのはjson.loadsメソッドを使います。

リスト内包表記で辞書にしてロード結果を返して、その結果から「イギリス」に関する内容を

実行結果がこちら。確認$ python nlp20.py {{redirect|UK}} {{基礎情報 国 |略名 = イギリス |日本語国名 = グレートブリテン及び北アイルランド連合王国 ...(略)うん、イギリスの情報が取れていそうですね。

21. カテゴリ名を含む行を抽出

記事中でカテゴリ名を宣言している行を抽出せよ.

カテゴリ名の書き方については、 https://ja.wikipedia.org/wiki/Help:カテゴリ によると以下の通りだそうです。

同じカテゴリに属すページをまとめるには、[[Category:カテゴリ名]]あるいは、[[Category:カテゴリ名|ソートキー]]と記述します。

というわけで、「[[Category:」を含む行を探してあげれば良さそうです。

先程のコードの続きでカテゴリ名がある行を抽出してみましょう。nlp20.py-つづきcategory_lines = [line for line in england.split('\n') if '[[Category:' in line] print(category_lines)

englandの中には先程取り出した「イギリス」の記事本文が入っています。

リスト内包表記内ではこれを改行コードで分割し、if 文で「[[Category:」を含む行だけを取り出しています。

実行結果がこちら。確認$ python nlp20.py ['[[Category:イギリス|*]]', '[[Category:英連邦王国|*]]', '[[Category:G8加盟国]]', '[[Category:欧州連合加盟国]]', '[[Category:海洋国家]]', '[[Category:君主国]]', '[[Category:島国|くれいとふりてん]]', '[[Category:1801年に設立された州・地域]]']こちらも正しく取れていそうです。

22. カテゴリ名の抽出

記事のカテゴリ名を(行単位ではなく名前で)抽出せよ.

いよいよ真面目に正規表現を使います。

先程引用したとおり、カテゴリ名のフォーマットは「[[Category:カテゴリ名]]あるいは、[[Category:カテゴリ名|ソートキー]]」です。

これをどちらもまとめて引っ掛けられる正規表現は\[\[Category:(.*?)(\|.*?)\]\]という感じでしょうか。

一個目のカッコ内が求めるカテゴリ名に当たります。

二個目のカッコはソートキーが指定されている場合にそれをカテゴリ名に含めないための指定です。では、これで抽出できるか試してみましょうか。

今度も先程のコードの続きに書きます。nlp20.py-さらにつづきcategories = [t[0] for t in re.findall(r'\[\[Category:(.*?)(\|.*?)?\]\]', england)] print(categories)

re.findallを使って、指定した正規表現に適合する箇所をすべて取得しています。

t[0]には一個目のカッコの内容、t[1]には二個目のカッコの内容が入ってきます。

結果がこちら。確認$ python nlp20.py ['イギリス', '英連邦王国', 'G8加盟国', '欧州連合加盟国', '海洋国家', '君主国', '島国', '1801年に設立された州・地域']さきほどの 21 で抽出された各行のカテゴリ名が取れていますね。

23. セクション構造

記事中に含まれるセクション名とそのレベル(例えば"== セクション名 =="なら1)を表示せよ.

nlp20.py-さらにつづきfor section in re.findall(r'(=+)([^=]+)\1\n', england): print('{}\t{}'.format(section[1].strip(), len(section[0])-1))ここでは正規表現内でカッコに括った範囲を「\1」を利用して参照しています。

# 正規表現 意味 ===外交と軍事===\nでマッチする部分 1 (=+)「=」1文字以上が続くだけ全部マッチ 最初の "===" 2 ([^=]+)「=」以外の文字(i.e. [^=])が1文字以上続くだけ全部マッチ 外交と軍事 3 \1#1の内容と同じものがここでマッチする。 二回目の "===" 4 \n改行 \n

re.findallが返してくれる各マッチ箇所のデータには、[0]に1つ目のカッコ内の内容、つまり '=' の連続が、[1]には 2つ目のカッコ内の内容すなわちセクション名が入っています。

なお、セクションのレベルは「=」の数-1になるので、len(section[0])-1としてレベルを算出しています。確認国名 1 歴史 1 地理 1 気候 2 政治 1 外交と軍事 1 地方行政区分 1 主要都市 2 科学技術 1 経済 1 鉱業 2 農業 2 貿易 2 通貨 2 企業 2 交通 1 道路 2 鉄道 2 海運 2 航空 2 通信 1 国民 1 言語 2 宗教 2 婚姻 2 教育 2 文化 1 食文化 2 文学 2 哲学 2 音楽 2 イギリスのポピュラー音楽 3 映画 2 コメディ 2 国花 2 世界遺産 2 祝祭日 2 スポーツ 1 サッカー 2 競馬 2 モータースポーツ 2 脚注 1 関連項目 1 外部リンク 124. ファイル参照の抽出

記事から参照されているメディアファイルをすべて抜き出せ.

メディアファイルの書き方ですが、

[[File:ファイル名]]あるいは[[ファイル:ファイル名]]が基本のようです。[[File:ファイル名|オプション]]の形式でファイル名の後にパイプ(|)区切りでオプション情報を付与することも出来ます。詳細はこちらを。nlp20.py-つづきfor file in re.findall(r'\[\[(ファイル|File):([^]|]+?)(\|.*?)+\]\]', england): print(file[1])そこで、こんな感じに正規表現を書いてあげれば、前項と同様に2つ目のカッコの中を取り出すことでファイル名だけを取り出すことが出来ます。

結果Royal Coat of Arms of the United Kingdom.svg Battle of Waterloo 1815.PNG The British Empire.png Uk topo en.jpg BenNevis2005.jpg Elizabeth II greets NASA GSFC employees, May 8, 2007 edit.jpg Palace of Westminster, London - Feb 2007.jpg David Cameron and Barack Obama at the G20 Summit in Toronto.jpg Soldiers Trooping the Colour, 16th June 2007.jpg Scotland Parliament Holyrood.jpg London.bankofengland.arp.jpg City of London skyline from London City Hall - Oct 2008.jpg Oil platform in the North SeaPros.jpg Eurostar at St Pancras Jan 2008.jpg Heathrow T5.jpg Anglospeak.svg CHANDOS3.jpg The Fabs.JPG Wembley Stadium, illuminated.jpg25. テンプレートの抽出

記事中に含まれる「基礎情報」テンプレートのフィールド名と値を抽出し,辞書オブジェクトとして格納せよ.

テンプレートについてはこちらを見ていただければと思いますが、書式はさきほどのファイルの場合と似ていて、

{{テンプレート名|オプション|オプション...}}といった書式です。

ただ実際のデータを見てみると、これまでとちがって{{から}}までの間に改行が入っていたりするようですね。

あと、前の24でも本当は気にすべきだったのですが、「オプション」の位置で更に{{テンプレート名}}の形式でテンプレートが入っていたりするようです。つまり、{{~}}のカッコが入れ子になってしまっているんですね。これは難題です。

というのも、正規表現は基本的に入れ子構造が苦手なんですね。事実上入れ子は標準的な正規表現では扱えません1。

そこで、簡易的なパーサーを作って、ちゃんと入れ子構造も考慮した形にしてみました。

説明は・・・長くなるので省きます。nlp20.py-つづきdef parse_article(article): """ 渡されたarticleの内容をパースします。 基本的には文字列のリストになって帰ってきますが、 テンプレート、内部リンクの場合はリストが一段深くネストされて帰ってきます。 下の doctest を見たほうがわかりやすいかと。 >>> parse_article('foo{{bar|opt1=value1|opt2={{template|opt1=value100|opt2=value101}}hoge[[link|printed]]|opt3=huga}}') ['foo', ['{{', 'bar', '|', 'opt1', '=', 'value1', '|', 'opt2', '=', ['{{', 'template', '|', 'opt1', '=', 'value100', '|', 'opt2', '=', 'value101', '}}'], 'hoge', ['[[', 'link', '|', 'printed', ']]'], '|', 'opt3', '=', 'huga', '}}']] """ parsed = [[]] for s in re.findall(r'{{|}}|\[\[|\]\]|\||=|[^{}\[\]|=]+', article): if s in ('{{', '[['): parsed[-1].append([s]) parsed.append(parsed[-1][-1]) elif s in ('}}', ']]'): parsed[-1].append(s) parsed.remove(parsed[-1]) else: parsed[-1].append(s) return parsed[0] def join_all(nested_list): """ リストを文字列として連結します。 リスト内の要素にリストが有った場合、再帰的に連結を行います。 >>> join_all(['a', ['b', ['c', 'd'], 'e'], 'f']) 'abcdef' """ return ''.join([join_all(i) if type(i) is list else i for i in nested_list]) result = {} for item in parse_article(england): # 基礎情報〜という名前のテンプレートを探す if type(item) is list and item[0] == '{{' and item[1].startswith('基礎情報'): # テンプレート内の '|' のインデックスを全部見つける。 option_indices = [i for i, s in enumerate(item) if s == '|'] for i in option_indices: # '|' の次の要素がオプション名 key = item[i+1] # オプションの値は、'|' の3つ先以降、'|' か '}}' が出てくるまで。 value = itertools.takewhile(lambda s: s not in ('|', '}}'), item[i+3:]) # 辞書に突っ込む。 result[key.strip()] = join_all(value).strip() pprint.pprint(result)doctestは出力が長いときに改行が入れられないのが若干イマイチですね。

(doctestでそこまで頑張ったテストを書くなということかも)これを実行すると、しっかりパースできたことがわかります。

結果{'GDP/人': '36,727<ref name="imf-statistics-gdp" />', 'GDP値': '2兆3162億<ref name="imf-statistics-gdp" />', 'GDP値MER': '2兆4337億<ref name="imf-statistics-gdp" />', 'GDP値元': '1兆5478億<ref ' 'name="imf-statistics-gdp">http://www.imf.org/external/pubs/ft/weo/2012/02/weodata/weorept.aspx?pr.x=70&pr.y=13&sy=2010&ey=2012&scsm=1&ssd=1&sort=country&ds=.&br=1&c=112&s=NGDP%2CNGDPD%2CPPPGDP%2CPPPPC&grp=0&a= ' 'IMF>Data and Statistics>World Economic Outlook Databases>By ' 'Countrise>United Kingdom</ref>', 'GDP統計年': '2012', 'GDP統計年MER': '2012', 'GDP統計年元': '2012', 'GDP順位': '6', 'GDP順位MER': '5', 'ISO 3166-1': 'GB / GBR', 'ccTLD': '[[.uk]] / [[.gb]]<ref>使用は.ukに比べ圧倒的少数。</ref>', '人口値': '63,181,775<ref>http://esa.un.org/unpd/wpp/Excel-Data/population.htm ' 'United Nations Department of Economic and Social Affairs>Population ' 'Division>Data>Population>Total Population</ref>', '人口大きさ': '1 E7', '人口密度値': '246', '人口統計年': '2011', '人口順位': '22', '位置画像': 'Location_UK_EU_Europe_001.svg', '元首等氏名': '[[エリザベス2世]]', '元首等肩書': '[[イギリスの君主|女王]]', '公式国名': '{{lang|en|United Kingdom of Great Britain and Northern ' 'Ireland}}<ref>英語以外での正式国名:<br/>\n' '*{{lang|gd|An Rìoghachd Aonaichte na Breatainn Mhòr agus Eirinn mu ' 'Thuath}}([[スコットランド・ゲール語]])<br/>\n' '*{{lang|cy|Teyrnas Gyfunol Prydain Fawr a Gogledd ' 'Iwerddon}}([[ウェールズ語]])<br/>\n' '*{{lang|ga|Ríocht Aontaithe na Breataine Móire agus Tuaisceart na ' 'hÉireann}}([[アイルランド語]])<br/>\n' '*{{lang|kw|An Rywvaneth Unys a Vreten Veur hag Iwerdhon ' 'Glédh}}([[コーンウォール語]])<br/>\n' '*{{lang|sco|Unitit Kinrick o Great Breetain an Northren ' 'Ireland}}([[スコットランド語]])<br/>\n' '**{{lang|sco|Claught Kängrick o Docht Brätain an Norlin ' 'Airlann}}、{{lang|sco|Unitet Kängdom o Great Brittain an Norlin ' 'Airlann}}(アルスター・スコットランド語)</ref>', '公用語': '[[英語]](事実上)', '国旗画像': 'Flag of the United Kingdom.svg', '国歌': '[[女王陛下万歳|神よ女王陛下を守り給え]]', '国章リンク': '([[イギリスの国章|国章]])', '国章画像': '[[ファイル:Royal Coat of Arms of the United Kingdom.svg|85px|イギリスの国章]]', '国際電話番号': '44', '夏時間': '+1', '建国形態': '建国', '日本語国名': 'グレートブリテン及び北アイルランド連合王国', '時間帯': '±0', '最大都市': 'ロンドン', '標語': '{{lang|fr|Dieu et mon droit}}<br/>([[フランス語]]:神と私の権利)', '水面積率': '1.3%', '注記': '<references />', '略名': 'イギリス', '確立年月日1': '[[927年]]/[[843年]]', '確立年月日2': '[[1707年]]', '確立年月日3': '[[1801年]]', '確立年月日4': '[[1927年]]', '確立形態1': '[[イングランド王国]]/[[スコットランド王国]]<br />(両国とも[[連合法 (1707年)|1707年連合法]]まで)', '確立形態2': '[[グレートブリテン王国]]建国<br />([[連合法 (1707年)|1707年連合法]])', '確立形態3': '[[グレートブリテン及びアイルランド連合王国]]建国<br />([[連合法 (1800年)|1800年連合法]])', '確立形態4': "現在の国号「'''グレートブリテン及び北アイルランド連合王国'''」に変更", '通貨': '[[スターリング・ポンド|UKポンド]] (£)', '通貨コード': 'GBP', '面積値': '244,820', '面積大きさ': '1 E11', '面積順位': '76', '首相等氏名': '[[デーヴィッド・キャメロン]]', '首相等肩書': '[[イギリスの首相|首相]]', '首都': '[[ロンドン]]'}26. 強調マークアップの除去

25の処理時に,テンプレートの値からMediaWikiの強調マークアップ(弱い強調,強調,強い強調のすべて)を除去してテキストに変換せよ(参考: マークアップ早見表).

ここで言う「弱い強調」「強調」「強い強調」は、現在のリンク先では「他との区別」「強調」「車体と強調」と名前が変わっているようです。

''他との区別'''''強調''''''''斜体と強調'''''と、シングルクォート 2 / 3 / 5個連続している場合に、除去してしまえばいいわけですね。25がめんどかったのに、急に簡単。辞書に突っ込むところで、これらをリプレースしてしまいましょう。

nlp20.py-途中を差し替えresult = {} for item in parse_article(england): # 基礎情報〜という名前のテンプレートを探す if type(item) is list and item[0] == '{{' and item[1].startswith('基礎情報'): # テンプレート内の '|' のインデックスを全部見つける。 option_indices = [i for i, s in enumerate(item) if s == '|'] for i in option_indices: # '|' の次の要素がオプション名 key = item[i+1] # オプションの値は、'|' の3つ先以降、'|' か '}}' が出てくるまで。 value = itertools.takewhile(lambda s: s not in ('|', '}}'), item[i+3:]) # '' / ''' / ''''' を除去する。 value_str = re.sub(r"'{2,3}|'{5}", '', join_all(list(value))) # 辞書に突っ込む。 result[key] = value_str pprint.pprint(result)これで実行すると、強調が消えます。実際のデータでは

'''しかない気がしますが。結果{'GDP/人': '36,727<ref name="imf-statistics-gdp" />', 'GDP値': '2兆3162億<ref name="imf-statistics-gdp" />', 'GDP値MER': '2兆4337億<ref name="imf-statistics-gdp" />', 'GDP値元': '1兆5478億<ref ' 'name="imf-statistics-gdp">http://www.imf.org/external/pubs/ft/weo/2012/02/weodata/weorept.aspx?pr.x=70&pr.y=13&sy=2010&ey=2012&scsm=1&ssd=1&sort=country&ds=.&br=1&c=112&s=NGDP%2CNGDPD%2CPPPGDP%2CPPPPC&grp=0&a= ' 'IMF>Data and Statistics>World Economic Outlook Databases>By ' 'Countrise>United Kingdom</ref>', 'GDP統計年': '2012', 'GDP統計年MER': '2012', 'GDP統計年元': '2012', 'GDP順位': '6', 'GDP順位MER': '5', 'ISO 3166-1': 'GB / GBR', 'ccTLD': '[[.uk]] / [[.gb]]<ref>使用は.ukに比べ圧倒的少数。</ref>', '人口値': '63,181,775<ref>http://esa.un.org/unpd/wpp/Excel-Data/population.htm ' 'United Nations Department of Economic and Social Affairs>Population ' 'Division>Data>Population>Total Population</ref>', '人口大きさ': '1 E7', '人口密度値': '246', '人口統計年': '2011', '人口順位': '22', '位置画像': 'Location_UK_EU_Europe_001.svg', '元首等氏名': '[[エリザベス2世]]', '元首等肩書': '[[イギリスの君主|女王]]', '公式国名': '{{lang|en|United Kingdom of Great Britain and Northern ' 'Ireland}}<ref>英語以外での正式国名:<br/>\n' '*{{lang|gd|An Rìoghachd Aonaichte na Breatainn Mhòr agus Eirinn mu ' 'Thuath}}([[スコットランド・ゲール語]])<br/>\n' '*{{lang|cy|Teyrnas Gyfunol Prydain Fawr a Gogledd ' 'Iwerddon}}([[ウェールズ語]])<br/>\n' '*{{lang|ga|Ríocht Aontaithe na Breataine Móire agus Tuaisceart na ' 'hÉireann}}([[アイルランド語]])<br/>\n' '*{{lang|kw|An Rywvaneth Unys a Vreten Veur hag Iwerdhon ' 'Glédh}}([[コーンウォール語]])<br/>\n' '*{{lang|sco|Unitit Kinrick o Great Breetain an Northren ' 'Ireland}}([[スコットランド語]])<br/>\n' '**{{lang|sco|Claught Kängrick o Docht Brätain an Norlin ' 'Airlann}}、{{lang|sco|Unitet Kängdom o Great Brittain an Norlin ' 'Airlann}}(アルスター・スコットランド語)</ref>', '公用語': '[[英語]](事実上)', '国旗画像': 'Flag of the United Kingdom.svg', '国歌': '[[女王陛下万歳|神よ女王陛下を守り給え]]', '国章リンク': '([[イギリスの国章|国章]])', '国章画像': '[[ファイル:Royal Coat of Arms of the United Kingdom.svg|85px|イギリスの国章]]', '国際電話番号': '44', '夏時間': '+1', '建国形態': '建国', '日本語国名': 'グレートブリテン及び北アイルランド連合王国', '時間帯': '±0', '最大都市': 'ロンドン', '標語': '{{lang|fr|Dieu et mon droit}}<br/>([[フランス語]]:神と私の権利)', '水面積率': '1.3%', '注記': '<references />', '略名': 'イギリス', '確立年月日1': '[[927年]]/[[843年]]', '確立年月日2': '[[1707年]]', '確立年月日3': '[[1801年]]', '確立年月日4': '[[1927年]]', '確立形態1': '[[イングランド王国]]/[[スコットランド王国]]<br />(両国とも[[連合法 (1707年)|1707年連合法]]まで)', '確立形態2': '[[グレートブリテン王国]]建国<br />([[連合法 (1707年)|1707年連合法]])', '確立形態3': '[[グレートブリテン及びアイルランド連合王国]]建国<br />([[連合法 (1800年)|1800年連合法]])', '確立形態4': '現在の国号「グレートブリテン及び北アイルランド連合王国」に変更', '通貨': '[[スターリング・ポンド|UKポンド]] (£)', '通貨コード': 'GBP', '面積値': '244,820', '面積大きさ': '1 E11', '面積順位': '76', '首相等氏名': '[[デーヴィッド・キャメロン]]', '首相等肩書': '[[イギリスの首相|首相]]', '首都': '[[ロンドン]]'}27. 内部リンクの除去

26の処理に加えて,テンプレートの値からMediaWikiの内部リンクマークアップを除去し,テキストに変換せよ(参考: マークアップ早見表).

さっきよりは若干面倒な問題。

内部リンクには大きく二種類の書き方があるようで、[[記事名]]と記事に対してリンクしつつ、表示される文字も記事名そのものの場合と、[[記事名|表示文字]]と記事名と表示される文字が異なるパターン。

また、先に出てきた画像の場合は、[[画像ファイル名|オプション...|代替文]]というフォーマットになるため2、結局パイプ区切りの最後を取ればいいという結論になります。

[[Category:...]]という形式のカテゴリ表記に関してはここでは無視します。なぜならちょっと疲れてきたから。nlp20.py-差し替えresult = {} for item in parse_article(england): # 基礎情報〜という名前のテンプレートを探す if type(item) is list and item[0] == '{{' and item[1].startswith('基礎情報'): # テンプレート内の '|' のインデックスを全部見つける。 option_indices = [i for i, s in enumerate(item) if s == '|'] for i in option_indices: # '|' の次の要素がオプション名 key = item[i+1] # オプションの値は、'|' の3つ先以降、'|' か '}}' が出てくるまで。 value = itertools.takewhile(lambda s: s not in ('|', '}}'), item[i+3:]) # '' / ''' / ''''' を除去する value_str = re.sub(r"'{2,3}|'{5}", '', join_all(value).strip()) # 内部リンク(画像等も含む)を除去する。代替文があればそれを採用する。(つまりパイプ区切りの最後) value_str = re.sub(r"\[\[([^|\]]+\|)*(.*?)\]\]", "\\2", value_str) # 辞書に突っ込む。 result[key.strip()] = value_str pprint.pprint(result)実行すると内部リンクが処理されていることがわかります。

結果{'GDP/人': '36,727<ref name="imf-statistics-gdp" />', 'GDP値': '2兆3162億<ref name="imf-statistics-gdp" />', 'GDP値MER': '2兆4337億<ref name="imf-statistics-gdp" />', 'GDP値元': '1兆5478億<ref ' 'name="imf-statistics-gdp">http://www.imf.org/external/pubs/ft/weo/2012/02/weodata/weorept.aspx?pr.x=70&pr.y=13&sy=2010&ey=2012&scsm=1&ssd=1&sort=country&ds=.&br=1&c=112&s=NGDP%2CNGDPD%2CPPPGDP%2CPPPPC&grp=0&a= ' 'IMF>Data and Statistics>World Economic Outlook Databases>By ' 'Countrise>United Kingdom</ref>', 'GDP統計年': '2012', 'GDP統計年MER': '2012', 'GDP統計年元': '2012', 'GDP順位': '6', 'GDP順位MER': '5', 'ISO 3166-1': 'GB / GBR', 'ccTLD': '.uk / .gb<ref>使用は.ukに比べ圧倒的少数。</ref>', '人口値': '63,181,775<ref>http://esa.un.org/unpd/wpp/Excel-Data/population.htm ' 'United Nations Department of Economic and Social Affairs>Population ' 'Division>Data>Population>Total Population</ref>', '人口大きさ': '1 E7', '人口密度値': '246', '人口統計年': '2011', '人口順位': '22', '位置画像': 'Location_UK_EU_Europe_001.svg', '元首等氏名': 'エリザベス2世', '元首等肩書': '女王', '公式国名': '{{lang|en|United Kingdom of Great Britain and Northern ' 'Ireland}}<ref>英語以外での正式国名:<br/>\n' '*{{lang|gd|An Rìoghachd Aonaichte na Breatainn Mhòr agus Eirinn mu ' 'Thuath}}(スコットランド・ゲール語)<br/>\n' '*{{lang|cy|Teyrnas Gyfunol Prydain Fawr a Gogledd ' 'Iwerddon}}(ウェールズ語)<br/>\n' '*{{lang|ga|Ríocht Aontaithe na Breataine Móire agus Tuaisceart na ' 'hÉireann}}(アイルランド語)<br/>\n' '*{{lang|kw|An Rywvaneth Unys a Vreten Veur hag Iwerdhon ' 'Glédh}}(コーンウォール語)<br/>\n' '*{{lang|sco|Unitit Kinrick o Great Breetain an Northren ' 'Ireland}}(スコットランド語)<br/>\n' '**{{lang|sco|Claught Kängrick o Docht Brätain an Norlin ' 'Airlann}}、{{lang|sco|Unitet Kängdom o Great Brittain an Norlin ' 'Airlann}}(アルスター・スコットランド語)</ref>', '公用語': '英語(事実上)', '国旗画像': 'Flag of the United Kingdom.svg', '国歌': '神よ女王陛下を守り給え', '国章リンク': '(国章)', '国章画像': 'イギリスの国章', '国際電話番号': '44', '夏時間': '+1', '建国形態': '建国', '日本語国名': 'グレートブリテン及び北アイルランド連合王国', '時間帯': '±0', '最大都市': 'ロンドン', '標語': '{{lang|fr|Dieu et mon droit}}<br/>(フランス語:神と私の権利)', '水面積率': '1.3%', '注記': '<references />', '略名': 'イギリス', '確立年月日1': '927年/843年', '確立年月日2': '1707年', '確立年月日3': '1801年', '確立年月日4': '1927年', '確立形態1': 'イングランド王国/スコットランド王国<br />(両国とも1707年連合法まで)', '確立形態2': 'グレートブリテン王国建国<br />(1707年連合法)', '確立形態3': 'グレートブリテン及びアイルランド連合王国建国<br />(1800年連合法)', '確立形態4': '現在の国号「グレートブリテン及び北アイルランド連合王国」に変更', '通貨': 'UKポンド (£)', '通貨コード': 'GBP', '面積値': '244,820', '面積大きさ': '1 E11', '面積順位': '76', '首相等氏名': 'デーヴィッド・キャメロン', '首相等肩書': '首相', '首都': 'ロンドン'}28. MediaWikiマークアップの除去

27の処理に加えて,テンプレートの値からMediaWikiマークアップを可能な限り除去し,国の基本情報を整形せよ.

まあ、可能な限りきれいにしろってことですね。

ここでは、以下の3つを追加でやってみました。

- タグの除去

- {{lang}}テンプレート を文字列部分だけに

- <br> タグを改行に

というわけで再度差し替え版。

nlp20.py-差し替えresult = {} for item in parse_article(england): # 基礎情報〜という名前のテンプレートを探す if type(item) is list and item[0] == '{{' and item[1].startswith('基礎情報'): # テンプレート内の '|' のインデックスを全部見つける。 option_indices = [i for i, s in enumerate(item) if s == '|'] for i in option_indices: # '|' の次の要素がオプション名 key = item[i+1] # オプションの値は、'|' の3つ先以降、'|' か '}}' が出てくるまで。 value = itertools.takewhile(lambda s: s not in ('|', '}}'), item[i+3:]) # '' / ''' / ''''' を除去する value_str = re.sub(r"'{2,3}|'{5}", '', join_all(value).strip()) # 内部リンク(画像等も含む)を除去する。代替文があればそれを採用する。(つまりパイプ区切りの最後) value_str = re.sub(r"\[\[([^|\]]+\|)*(.*?)\]\]", "\\2", value_str) # <ref> タグを除去。<ref ... /> の書き方と <ref ...>...</ref> の書き方がある。 # (?s) は . を改行文字にもヒットさせるためのフラグ。 value_str = re.sub(r"(?s)<ref[^>]*?/>|<ref[^>]*?>.*?</ref>", '', value_str) # {{lang|言語タグ|文字列}} を文字列部分だけにする value_str = re.sub(r"{{lang\|[^|]+\|(.*?)}}", '\\1', value_str) # <br> タグを \n に置換 value_str = re.sub(r"<br\s*?/>", '\n', value_str) # 辞書に突っ込む。 result[key.strip()] = value_str pprint.pprint(result)結果はこちら。

結果{'GDP/人': '36,727', 'GDP値': '2兆3162億', 'GDP値MER': '2兆4337億', 'GDP値元': '1兆5478億', 'GDP統計年': '2012', 'GDP統計年MER': '2012', 'GDP統計年元': '2012', 'GDP順位': '6', 'GDP順位MER': '5', 'ISO 3166-1': 'GB / GBR', 'ccTLD': '.uk / .gb', '人口値': '63,181,775', '人口大きさ': '1 E7', '人口密度値': '246', '人口統計年': '2011', '人口順位': '22', '位置画像': 'Location_UK_EU_Europe_001.svg', '元首等氏名': 'エリザベス2世', '元首等肩書': '女王', '公式国名': 'United Kingdom of Great Britain and Northern Ireland', '公用語': '英語(事実上)', '国旗画像': 'Flag of the United Kingdom.svg', '国歌': '神よ女王陛下を守り給え', '国章リンク': '(国章)', '国章画像': 'イギリスの国章', '国際電話番号': '44', '夏時間': '+1', '建国形態': '建国', '日本語国名': 'グレートブリテン及び北アイルランド連合王国', '時間帯': '±0', '最大都市': 'ロンドン', '標語': 'Dieu et mon droit\n(フランス語:神と私の権利)', '水面積率': '1.3%', '注記': '', '略名': 'イギリス', '確立年月日1': '927年/843年', '確立年月日2': '1707年', '確立年月日3': '1801年', '確立年月日4': '1927年', '確立形態1': 'イングランド王国/スコットランド王国\n(両国とも1707年連合法まで)', '確立形態2': 'グレートブリテン王国建国\n(1707年連合法)', '確立形態3': 'グレートブリテン及びアイルランド連合王国建国\n(1800年連合法)', '確立形態4': '現在の国号「グレートブリテン及び北アイルランド連合王国」に変更', '通貨': 'UKポンド (£)', '通貨コード': 'GBP', '面積値': '244,820', '面積大きさ': '1 E11', '面積順位': '76', '首相等氏名': 'デーヴィッド・キャメロン', '首相等肩書': '首相', '首都': 'ロンドン'}だいぶ読みやすくなりましたね。

29. 国旗画像のURLを取得する

テンプレートの内容を利用し,国旗画像のURLを取得せよ.(ヒント: MediaWiki APIのimageinfoを呼び出して,ファイル参照をURLに変換すればよい)

最後は急にAPI呼び出し。

上記のページを読むと、以下のようなリクエストを送ればAPIでURLが取得できるようです。GET https://ja.wikipedia.org/w/api.php?action=query&format=json&prop=imageinfo&titles=File:Flag%20of%20the%20United%20Kingdom.svg&iiprop=url実際これを vscode の REST client で流してみた結果がこちら。

{ "continue": { "iistart": "2007-09-03T09:51:34Z", "continue": "||" }, "query": { "normalized": [ { "from": "File:Flag of the United Kingdom.svg", "to": "\u30d5\u30a1\u30a4\u30eb:Flag of the United Kingdom.svg" } ], "pages": { "-1": { "ns": 6, "title": "\u30d5\u30a1\u30a4\u30eb:Flag of the United Kingdom.svg", "missing": "", "known": "", "imagerepository": "shared", "imageinfo": [ { "url": "https://upload.wikimedia.org/wikipedia/commons/a/ae/Flag_of_the_United_Kingdom.svg", "descriptionurl": "https://commons.wikimedia.org/wiki/File:Flag_of_the_United_Kingdom.svg", "descriptionshorturl": "https://commons.wikimedia.org/w/index.php?curid=347935" } ] } } } }結果の query > pages > * > imageinfo[0] > url を取ればいいっぽいですね。

実際、pythonで呼び出してみましょう。

コードはさっきまでの続きです。resultに記事「イギリス」の基礎情報テンプレートの内容のパース結果が入っています。nlp20.py-つづきapi_url = 'https://ja.wikipedia.org/w/api.php?{}' params = { 'action': 'query', 'format': 'json', 'prop': 'imageinfo', 'titles': 'File:{}'.format(result['国旗画像']), 'iiprop': 'url' } req = urllib.request.Request(api_url.format(urllib.parse.urlencode(params))) with urllib.request.urlopen(req) as res: j = json.loads(res.read()) print(list(j['query']['pages'].values())[0]['imageinfo'][0]['url'])これでURLが表示されます。

結果https://upload.wikimedia.org/wikipedia/commons/a/ae/Flag_of_the_United_Kingdom.svgというわけで無事URLが表示されました。

第3章はこれでおしまい。25が難関でしたね。最初から真面目にパースしようとするのが結局一番早かった。

次回はいつになるかわかりませんが、また気が向いたら。

- 投稿日:2019-07-11T23:26:52+09:00

Flask appの名前付けにまつわる謎を解明したので解説

実行環境

OS: Ubuntu 18.04.2 LTS

python: 3.6.8

Flask: 1.1.1本文

以下のFlaskアプリケーションを起動させるファイルを実行してみた時に事件は起こった。

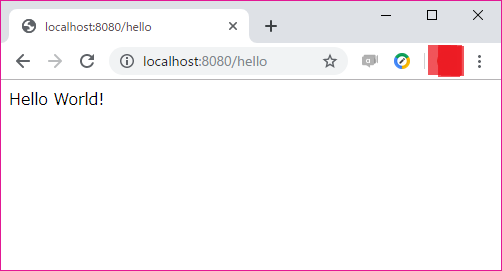

study_flask.pyfrom flask import Flask app = Flask(__name__) @app.route('/') def hello(): return "Hello World!" app.run()実行してみた結果は以下。

$ python study_flask.py * Serving Flask app "study_flask" (lazy loading) * Environment: production WARNING: This is a development server. Do not use it in a production deployment. Use a production WSGI server instead. * Debug mode: off * Running on http://127.0.0.1:5000/ (Press CTRL+C to quit)ふむふむちゃんとFlaskのサーバーが動いてくれてるなあ。

ん?

* Serving Flask app "study_flask" (lazy loading)んん?

Flask app "study_flask"んんんん???

お気付きであろうか。

直接実行したファイル内で__name__を名称としたFlask appを作成しているのに、

Flask app名が__main__ではなく、ファイル名になっていることに!一応解説しておくと、

__name__には基本的にファイル名が拡張子なしで保存される。

__name__が記述されたファイルが直接実行された時のみ"__main__"という文字列が入る。今回の場合は直接実行しているので、

__main__という名称のFlask appが出来上がると思っていたが違った。私はこのことに非常にもやもやし、

この理由を業務時間内に調べた。(あかん)いろんなサイトを見てみたが、

解説が載っているサイトを見つけられなかったため、

直接Flaskのソースコードを読むことにした。flask/app.pyclass Flask(_PackageBoundObject): """The flask object implements a WSGI application and acts as the central object. It is passed the name of the module or package of the application. Once it is created it will act as a central registry for the view functions, the URL rules, template configuration and much more. The name of the package is used to resolve resources from inside the package or the folder the module is contained in depending on if the package parameter resolves to an actual python package (a folder with an :file:`__init__.py` file inside) or a standard module (just a ``.py`` file). ~~省略〜〜 """ def __init__( self, import_name, static_url_path=None, static_folder="static", static_host=None, host_matching=False, subdomain_matching=False, template_folder="templates", instance_path=None, instance_relative_config=False, root_path=None, ):ふむふむ。

__name__は直接flaskの名称になるのではなく、

import_nameの引数として渡されている様だ。このimport_nameはself.import_nameに代入されていた。

さらに読み進めていくと以下のような関数を発見。

flask/app.pydef name(self): """The name of the application. This is usually the import name with the difference that it's guessed from the run file if the import name is main. This name is used as a display name when Flask needs the name of the application. It can be set and overridden to change the value. .. versionadded:: 0.8 """ if self.import_name == "__main__": fn = getattr(sys.modules["__main__"], "__file__", None) if fn is None: return "__main__" return os.path.splitext(os.path.basename(fn))[0] return self.import_name色々やってるけど、重要なのはここ↓

if self.import_name == "__main__": fn = getattr(sys.modules["__main__"], "__file__", None) "~~省略~~" return os.path.splitext(os.path.basename(fn))[0]もしself.import_nameが"main"だったら、

最初に実行したファイルの名称を取ってくるという処理が書かれていた!!なるほど。

結構単純だった。。実はここにたどり着くまでに時間かなり使っちゃった。

わかってみると単純なんだけどわからないうちは複雑。プログラミングなんて全部単純だよって言える人になりたいな。

- 投稿日:2019-07-11T23:26:52+09:00

【マニアック】Flaskにまつわる謎を一つ解明したので解説

実行環境

OS: Ubuntu 18.04.2 LTS

python: 3.6.8

Flask: 1.1.1本文

以下のFlaskアプリケーションを起動させるファイルを実行してみた時に事件は起こった。

study_flask.pyfrom flask import Flask app = Flask(__name__) @app.route('/') def hello(): return "Hello World!" app.run()実行してみた結果は以下。

$ python study_flask.py * Serving Flask app "study_flask" (lazy loading) * Environment: production WARNING: This is a development server. Do not use it in a production deployment. Use a production WSGI server instead. * Debug mode: off * Running on http://127.0.0.1:5000/ (Press CTRL+C to quit)ふむふむちゃんとFlaskのサーバーが動いてくれてるなあ。

ん?

* Serving Flask app "study_flask" (lazy loading)んん?

Flask app "study_flask"んんんん???

お気付きであろうか。

直接実行したファイル内で__name__を名称としたFlask appを作成しているのに、

Flask app名が__main__ではなく、ファイル名になっていることに!一応解説しておくと、

__name__には基本的にファイル名が拡張子なしで保存される。

__name__が記述されたファイルが直接実行された時のみ"__main__"という文字列が入る。今回の場合は直接実行しているので、

__main__という名称のFlask appが出来上がると思っていたが違った。私はこのことに非常にもやもやし、

この理由を業務時間内に調べた。(あかん)いろんなサイトを見てみたが、

解説が載っているサイトを見つけられなかったため、

直接Flaskのソースコードを読むことにした。flask/app.pyclass Flask(_PackageBoundObject): """The flask object implements a WSGI application and acts as the central object. It is passed the name of the module or package of the application. Once it is created it will act as a central registry for the view functions, the URL rules, template configuration and much more. The name of the package is used to resolve resources from inside the package or the folder the module is contained in depending on if the package parameter resolves to an actual python package (a folder with an :file:`__init__.py` file inside) or a standard module (just a ``.py`` file). ~~省略〜〜 """ def __init__( self, import_name, static_url_path=None, static_folder="static", static_host=None, host_matching=False, subdomain_matching=False, template_folder="templates", instance_path=None, instance_relative_config=False, root_path=None, ):ふむふむ。

__name__は直接flaskの名称になるのではなく、

import_nameの引数として渡されている様だ。このimport_nameはself.import_nameに代入されていた。

さらに読み進めていくと以下のような関数を発見。

flask/app.pydef name(self): """The name of the application. This is usually the import name with the difference that it's guessed from the run file if the import name is main. This name is used as a display name when Flask needs the name of the application. It can be set and overridden to change the value. .. versionadded:: 0.8 """ if self.import_name == "__main__": fn = getattr(sys.modules["__main__"], "__file__", None) if fn is None: return "__main__" return os.path.splitext(os.path.basename(fn))[0] return self.import_name色々やってるけど、重要なのはここ↓

if self.import_name == "__main__": fn = getattr(sys.modules["__main__"], "__file__", None) "~~省略~~" return os.path.splitext(os.path.basename(fn))[0]もしself.import_nameが"main"だったら、

最初に実行したファイルの名称を取ってくるという処理が書かれていた!!なるほど。

結構単純だった。。実はここにたどり着くまでに時間かなり使っちゃった。

わかってみると単純なんだけどわからないうちは複雑。プログラミングなんて全部単純だよって言える人になりたいな。

- 投稿日:2019-07-11T21:23:24+09:00

typing.Union[A,B]からAに変換するには

結論を1行で言うと

typing.cast(A, Union[A,B]のオブジェクト)せよ。発生した問題

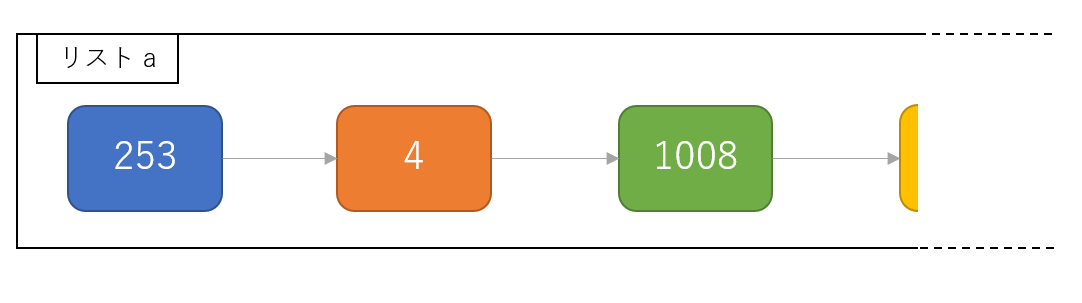

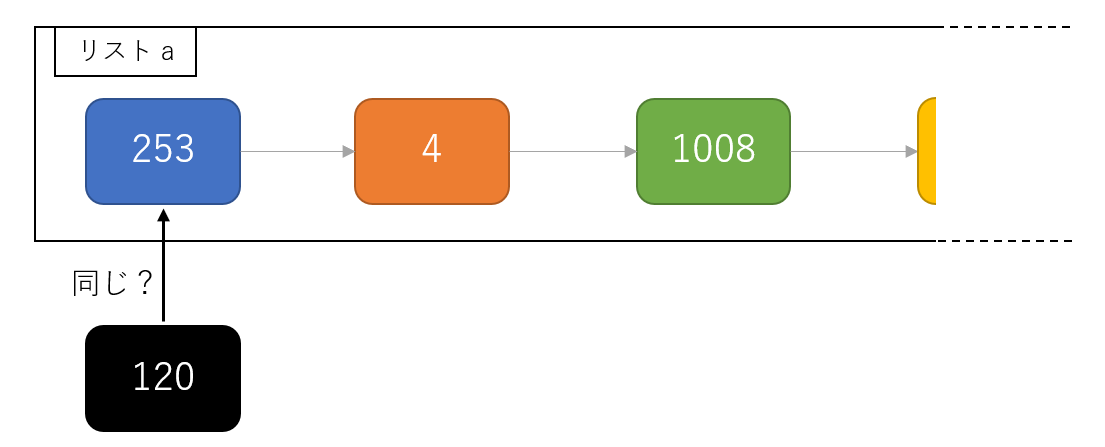

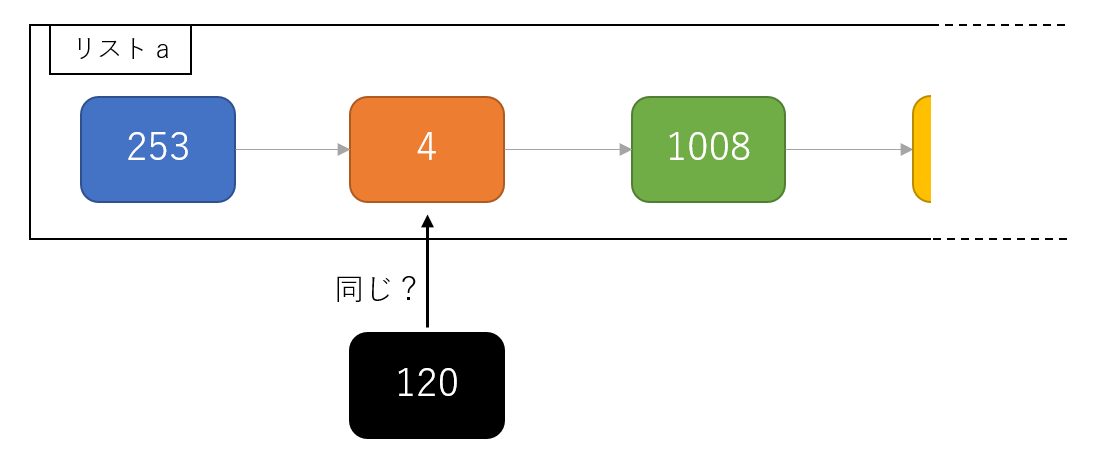

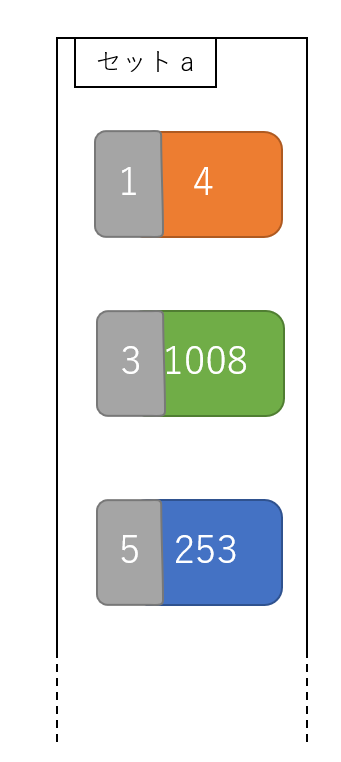

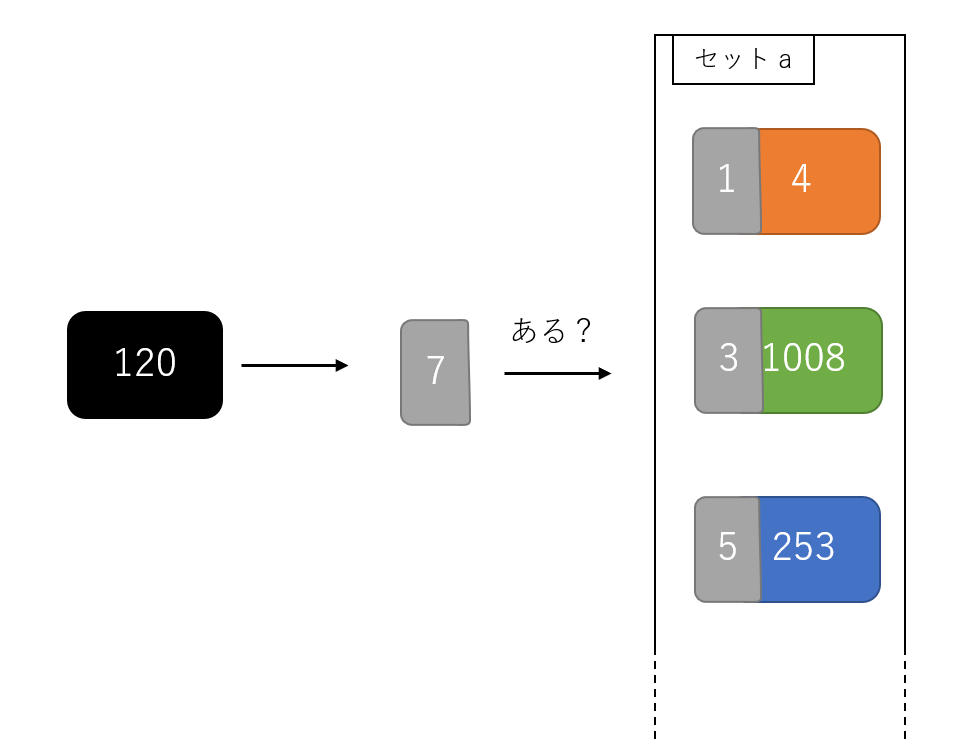

コレクションオブジェクト(リストを保持するクラス)を実装しているときに遭遇した問題。

# 財布クラス(説明用に今考えた) from typing import List, Union class Wallet: def __init__(self, coins: List[Coin]) -> None: self._wallet = coins def __getitem__(self, key: Union[int, slice]) -> Union[Coin, List[Coin]]: return self._wallet[key] # 硬貨クラス class Coin: def __init__(self, value: int) -> None: self.value = value @staticmethod def exchange(value) -> List[Coin]: # 複数の硬貨でお金を表現する。ロジックは割愛上のようなクラスがあったとする。利用するとしたらこんな感じ。

coins = Coin.exchange(1000) # Coin(100)が10個のリストができるイメージ wallet = Wallet(coins) coin = wallet[0] # mypyに怒られる何が起きているの?

最後の行では

mypyにincompatible type "Union[List[Coin], Coin]"; expected "Coin"と怒られる。

__getitem__側はintとsliceの両方に対応して、Union[Coin, List[Coin]]になっている。それに対し、

coin = wallet[0]の左辺ではCoinしか想定してないため、List[Coin]返ってきたらどうするの?責任取れるの?と聞いているわけ。解決策

コーディングする側からすると、「察してくださいよ。まあ慌てるなよ」と言いたいところだが、そうしたことが通用する相手ではない。

from typing import cast coin = cast(Coin, wallet[0])と型のキャストをしてあげればよい。もちろん、値には変更はない。

参考

- 投稿日:2019-07-11T19:45:36+09:00

【Python】画像の比率を維持して長辺を指定した長さに

コマンドで変更後の長辺の長さと画像を格納したディレクトリを指定します。

ファイル拡張子チェックは割愛。

python2.7で動作確認してますが、print関数だけ直せば3でも動くでしょう。コード

resize_max_side.py#!/usr/bin/python # -*- coding: UTF-8 -*- """feature detection.""" import sys import os import cv2 def resize(image, max_side_size): ori_height, ori_width = image.shape[:2] modi_height = max_side_size modi_width = max_side_size if ori_height > ori_width: modi_width = ori_width * modi_height / ori_height else: modi_height = ori_height * modi_width / ori_width size = (modi_height, modi_width) print str(size) resized_image = cv2.resize(image, size) return resized_image if __name__ == '__main__': args = sys.argv dir_path = args[1] max_side_size = int(args[2]) file_names = os.listdir(dir_path) for file_name in file_names: file_path = dir_path + file_name image = cv2.imread(file_path) resized_image = resize(image, max_side_size) cv2.imwrite(file_path, resized_image)実行

# python resize_max_side.py images/ 100

- 投稿日:2019-07-11T18:02:48+09:00

PythonのNaNに関する注意事項

- 投稿日:2019-07-11T18:00:42+09:00

pythonのはじめ方

python何から手をつけたらいいですか?とかIDEはなにを入れたらいいですか?と質問してくれた積極的な方がいたので説明用にメモを残します。

はじめに

対象

- pythonをやったことないけど、何から始めたらいいのか思いつかない人。

環境はWindowsを想定しています

私がWindowsもしくはLinuxを使っていてMacは使っていないので、

Windowsユーザ向けの情報です。流れ

- pythonインストール

- エディタインストール

- Hello World実行

- WebでHello World(bottle利用)

- おすすめの技術紹介

pythonインストール

Python公式ページでpython本体をダウンロードしましょう。

バージョンは3系を選択しましょう

pythonのバージョンには2系と3系があります。メジャーバージョンの違いのことですね。

python2.7.16とかpython3.7.4とかですね。ライブラリの対応バージョンにももちろん関連しますが、かなり3系に対応されて来ていますし構文も改善されているのでバージョンは3系を選択しましょう。python2とpython3の違いについては以下のページを参考にしてみてください。

- Python2からPython3.0での変更点(わかりやすい)

- 2系と3系の違い(わかりやすい)

- 【公式ページ】Python 2 から Python 3 への移植

- Supporting Python 3: An in-depth guide

32bit or 64bit

Downloadのボタンを押すとPCが64bitでも32bit版がダウンロードされます。

学習レベルでは64bitにこだわる必要はないと思いますが、必要であれば64bit版のinstallerを使いましょう。64bit版のダウンロードは以前投稿の最後"注意"という部分に書いてあります。

エディタをインストール

IDEについて

Java言語ならEclipse、C#はVisualStudioというように、pythonではJetBrains社のPyCharmというIDEを使うことが多いようです。(JetBrainsのIntelliJ IDEAもJava開発でシェアをEclipseと同等もしくはそれ以上に伸ばしている模様)

PyCharmを使うとvirtualenvとかcondaとか環境使えるしコード補完もあるから便利だと思います。

ただ、学習のため基礎もやっておくといいと思います。

また公式サイトの手順はIDEを使っていない前提で説明が書かれているので一通りやってみるにはコマンドプロンプトとエディタで取り組んでみることをおすすめします。エディタおすすめ

Hello Worldなどサクッとコード書いてみるにはちょっとしたエディタで十分だと思います。

個人的なおすすめは以下です。

pythonコードも見やすし、多少の補完もしてくれます。その気になればエディタ上から実行も可能です。

また、IDLEを使うのも学習用としてはいいと思います。

↓こちらに画面イメージとか載せておきました。

https://qiita.com/HyunwookPark/items/c7eef970c7d7c05b09adHello World実行

ソースコード書く

任意の場所にディレクトリを作成して.pyファイルを新規作成しましょう。

ソースコードの内容はまずはHelloWorldで。この内容だけならimport文も不要です。test.py

print('Hello World!!')実行

コマンドプロンプトもしくはWindows PowerShellで以下のようにコマンド実行してみましょう。

> python test.py Hello World!!WebでHello World(bottle利用)

ライブラリをインストール

ライブラリをインストール方法は色々ありますが、もっとも基本的なのはpipを使う方法でしょう。

コマンドプロンプトもしくはWindows PowerShellで以下のようにコマンド実行してみましょう。

> pip install bottle Collecting bottle Downloading https://files.pythonhosted.org/packages/69/d1/efdd0a5584169cdf791d726264089ce5d96846a8978c44ac6e13ae234327/bottle-0.12.17-py3-none-any.whl (89kB) |████████████████████████████████| 92kB 1.5MB/s Installing collected packages: bottle Successfully installed bottle-0.12.17ソースコードを書く

hellobottle.py

from bottle import route, run @route('/hello') def hello(): return "Hello World!" run(host='localhost', port=8080, debug=True)実行

> python hellobottle.py Bottle v0.12.17 server starting up (using WSGIRefServer())... Listening on http://localhost:8080/ Hit Ctrl-C to quit.ブラウザでアクセス

ブラウザで上記にアクセスするとサーバからの応答が確認できる。

おすすめの技術紹介

pythonに興味が湧いたら以下のようなライブラリで好きなものを作ってみましょう。

ライブラリ 概要 tkinter WindowアプリなどGUI画面を作るためのライブラリ(python標準搭載なのでインストール不要) NumPy 数学計算が得意なライブラリでCythonで記述されていて高速 pandas データ解析のためのライブラリでCSVの読み込みやデータ操作などができる matplotlib グラフ描画のライブラリでNumPyやpandasと組み合わせて使うことが多い scikit-learn 最近のお流行り"機械学習"のライブラリ Django Ruby on RailsっぽいWeb用フレームワークでログイン機能や画面を作るtemplate機能、O/Rマッパー機能などが含まれる bottle pとても軽量なWeb用フレームワークでURIからのルーティング機能が主な機能 Flask とても軽量なWeb用フレームワークでbottleよりシェアが多いように見える(使ったことないので語れません) pygame pythonでゲームを作るためのライブラリ Pyxel pythonでレトロゲームを作るためのライブラリ(個人的にやってみたいだけ) 参考

公式ドキュメント

おまけ

virtualenv

プロジェクトによって利用するpythonのバージョンが違っていたりLinuxではデフォルトでpython2がインストールされていてpython3がどうも使いづらかったりするときのために仮想環境を使うことが多いようです。

virtualenvというものです。

pycharmを使う場合はプロジェクトを作るときにvirtualenvの利用を聞かれたりします。

知っておくといいかも

技術名 概要 CPython 公式Pythonのこと Cython PythonのようなコーディングでコンパイルするとC言語のコードでPython拡張モジュールを作ることができる pyenv virtualenvのお友達 pypy pythonを高速実行できるとうわさのもの Anaconda pythonのディストリビューションでデータサイエンスおよび機械学習関連のライブラリが含まれる Jupyter Notebook Anacondaに含まれるツールで、デバッグのような実行方法ができるエディタのようなものグラフとか画像とかすぐ表示できる pip pythonのパッケージ管理ツール

- 投稿日:2019-07-11T17:58:01+09:00

Python+XPATH+Selenium(headless)で色々なサイトのランキング情報のスクレーピング

やりたいこと

Amazonやニュースサイトのランキングをタブで一括表示できるアプリがあると便利だな、と考えました。

けれど探しても見当たらないので、自分で作りました。

以下からダウンロードできますので是非使ってみてください(Androidのみ)

https://play.google.com/store/apps/details?id=atellieryotta.unsmart_newsサーバ側はPython+Selenium(headless)で一時間ごとに各サイトをスクレーピングし、サーバ上に保存、モバイルアプリ側は今はやりのflutterで構築し、そのデータを読み込んでいます。

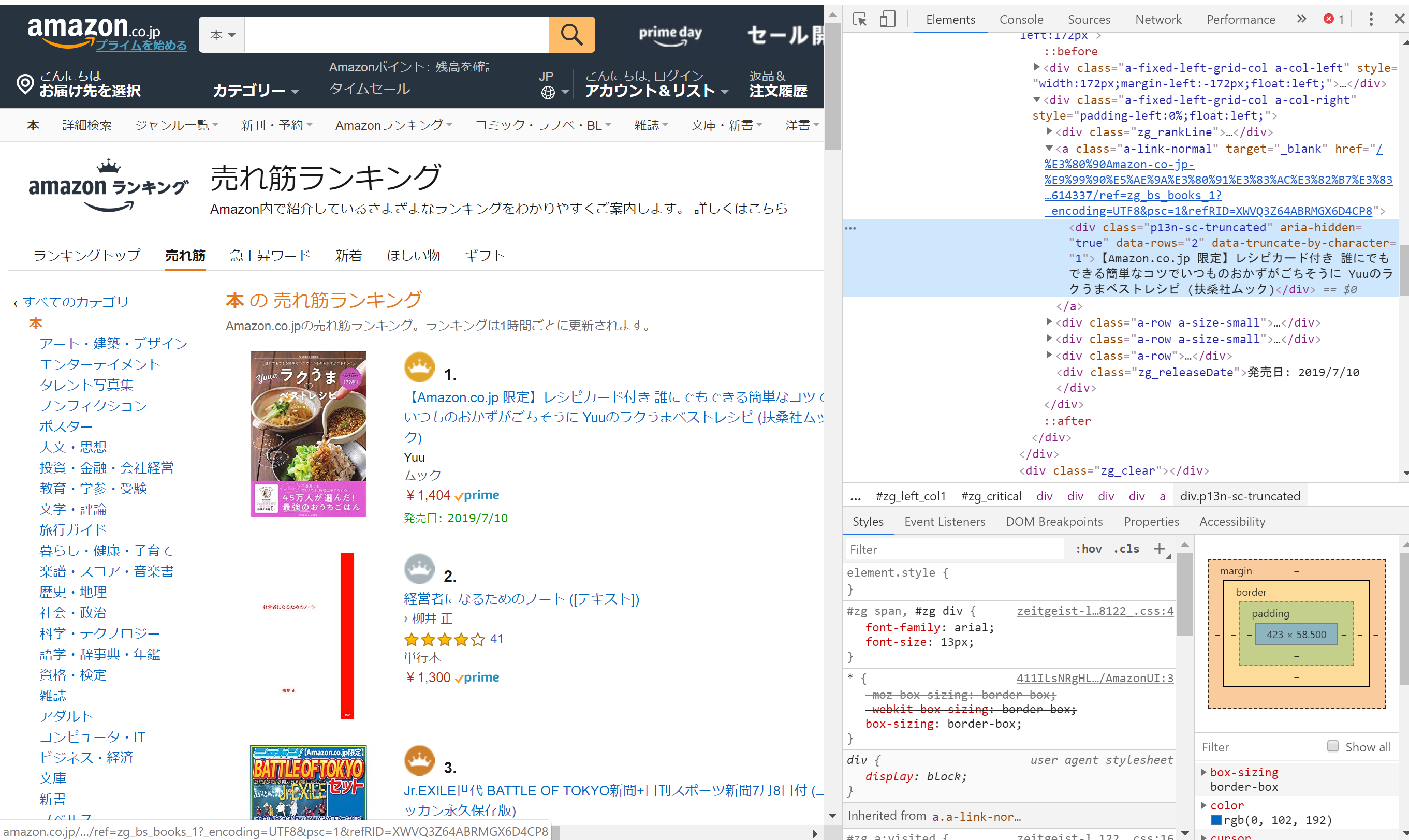

今回はサーバ側の内容をご紹介します。基本の手順(Amazonの本ランキング取得)

あらかじめ取得するサイトの構造が分かっているなら、XPATHによるスクレーピングが便利です。

XPATHを調べるにはChromeを使うのが簡単です。

今回はAmazonの本のランキングページを開き、本のタイトルのところで右クリック→「検証」を選択すると、

右側に開発者用のメニューが表示されるので、右クリックから→「Copy」→「Copy XPATH」を選択すると、クリップボートにXPATHがコピーされます。一位と二位について取得するとそれぞれ以下の通りであることがわかります。

//[@id="zg_critical"]/div[1]/div[1]/div/div[2]/a/div

//[@id="zg_critical"]/div[2]/div[1]/div/div[2]/a/div一つ目のdivの[]内を1~10に変えてやればよさそうです。

ただここにトラップがあり、ランキング1~3位と4位以降では@id以降が変わっています。

4位以降は以下のXPATHを取る必要があります。(iは可変)//*[@id="zg_nonCritical"]/div[{i}]/div[1]/div/div[2]/a/div

サイトによって仕様は異なるので何度かトライアンドエラーしながらXPATHを突き詰めていく必要があります。

タイトルに加えて、リンク先のURLやサムネイル画像のURLについても同様の手順でXPATHを確認できます。

最終的には以下のプログラムでランキングをスクレーピングできました。

(スクレーピングの際はサーバに過負荷をかけないようにご注意ください)amazon_book.pyimport sys,os import requests import bs4 import lxml.html import shutil fpath = "/tmp/hoge.tsv" url = 'https://www.amazon.co.jp/gp/bestsellers/books' url_base = 'https://www.amazon.co.jp/' response = requests.get(url) html = lxml.html.fromstring(response.content) f = open(fpath, mode="w"); for i in range(1,4): # rank 1~3 xpath1 = f'//*[@id="zg_critical"]/div[{i}]/div[1]/div/div[2]/a/div' # text, xpath2 = f'//*[@id="zg_critical"]/div[{i}]/div[1]/div/div[2]/a' # link xpath3 = f'//*[@id="zg_critical"]/div[{i}]/div[1]/div/div[1]/a/img' # image link1 = html.xpath(xpath1) link2 = html.xpath(xpath2) link3 = html.xpath(xpath3) text = link1[0].text.strip() href = link2[0].get("href").strip() # 空白が入り込むのでstrip image = link3[0].get("src").strip() f.write(f'{i} {url_base}{href} {text} {image}\n') for i in range(1,8): # rank 4~10 xpath1 = f'//*[@id="zg_nonCritical"]/div[{i}]/div[1]/div/div[2]/a/div' # text, xpath2 = f'//*[@id="zg_nonCritical"]/div[{i}]/div[1]/div/div[2]/a' # link xpath3 = f'//*[@id="zg_nonCritical"]/div[{i}]/div[1]/div/div[1]/a/img' # image link1 = html.xpath(xpath1) link2 = html.xpath(xpath2) link3 = html.xpath(xpath3) text = link1[0].text.strip() href = link2[0].get("href").strip() image = link3[0].get("src").strip() j = i+3 f.write(f'{j} {url_base}{href} {text} {image}\n') f.close()これを実行することで以下のような出力が得られます。

タブ区切りで、ランキング、リンク先URL、タイトル、サムネイルURLをダンプしています。hoge.tsv1 https://www.amazon.co.jp//%E3%80%90Amazon-co-jp-%E9%99%90%E5%AE%9A%E3%80%91%E3%83%AC%E3%82%B7%E3%83%94%E3%82%AB%E3%83%BC%E3%83%89%E4%BB%98%E3%81%8D-%E8%AA%B0%E3%81%AB%E3%81%A7%E3%82%82%E3%81%A7%E3%81%8D%E3%82%8B%E7%B0%A1%E5%8D%98%E3%81%AA%E3%82%B3%E3%83%84%E3%81%A7%E3%81%84%E3%81%A4%E3%82%82%E3%81%AE%E3%81%8A%E3%81%8B%E3%81%9A%E3%81%8C%E3%81%94%E3%81%A1%E3%81%9D%E3%81%86%E3%81%AB-Yuu%E3%81%AE%E3%83%A9%E3%82%AF%E3%81%86%E3%81%BE%E3%83%99%E3%82%B9%E3%83%88%E3%83%AC%E3%82%B7%E3%83%94-%E6%89%B6%E6%A1%91%E7%A4%BE%E3%83%A0%E3%83%83%E3%82%AF/dp/4594614337?_encoding=UTF8&psc=1 【Amazon.co.jp 限定】レシピカード付き 誰にでもできる簡単なコツでいつものおかずがご ちそうに Yuuのラクうまベストレシピ (扶桑社ムック) https://images-na.ssl-images-amazon.com/images/I/81sIUM7QXoL._AC_UL160_SR160,160_.jpg 2 https://www.amazon.co.jp//%E7%B5%8C%E5%96%B6%E8%80%85%E3%81%AB%E3%81%AA%E3%82%8B%E3%81%9F%E3%82%81%E3%81%AE%E3%83%8E%E3%83%BC%E3%83%88-%E3%83%86%E3%82%AD%E3%82%B9%E3%83%88-%E6%9F%B3%E4%BA%95-%E6%AD%A3/dp/4569826954?_encoding=UTF8&psc=1 経営者になるためのノ ート ([テキスト]) https://images-na.ssl-images-amazon.com/images/I/61aHoJlmwoL._AC_UL160_SR160,160_.jpg 3 https://www.amazon.co.jp//Jr-EXILE%E4%B8%96%E4%BB%A3-BATTLE-TOKYO%E6%96%B0%E8%81%9E-%E6%97%A5%E5%88%8A%E3%82%B9%E3%83%9D%E3%83%BC%E3%83%84%E6%96%B0%E8%81%9E7%E6%9C%888%E6%97%A5%E4%BB%98-%E3%83%8B%E3%83%83%E3%82%AB%E3%83%B3%E6%B0%B8%E4%B9%85%E4%BF%9D%E5%AD%98%E7%89%88/dp/B07TNVXLZH?_encoding=UTF8&psc=1 Jr.EXILE世代 BATTLE OF TOKYO新聞+日刊スポーツ新聞7月8日付 (ニッカン永久保存版) https://images-na.ssl-images-amazon.com/images/I/911FzCntefL._AC_UL160_SR160,160_.jpg 4 https://www.amazon.co.jp//%E5%A4%8F%E3%81%AE%E9%A8%8E%E5%A3%AB-%E7%99%BE%E7%94%B0-%E5%B0%9A%E6%A8%B9/dp/4103364149?_encoding=UTF8&psc=1 夏の騎士 https://images-na.ssl-images-amazon.com/images/I/81JqVie4p8L._AC_UL160_SR160,160_.jpg 5 https://www.amazon.co.jp//%E3%81%8F%E3%81%B3%E3%82%8C%E6%AF%8D%E3%81%A1%E3%82%83%E3%82%93%E3%81%AE%E3%82%86%E3%82%8B%E3%82%81%E3%82%8B%E3%82%AB%E3%83%A9%E3%83%80-DVD%E4%BB%98%E3%81%8D-%E6%89%B6%E6%A1%91%E7%A4%BE%E3%83%A0%E3%83%83%E3%82%AF-%E6%9D%91%E7%94%B0-%E5%8F%8B%E7%BE%8E%E5%AD%90/dp/4594614248?_encoding=UTF8&psc=1 くびれ母ちゃんのゆるめるカラダ DVD付き (扶桑社ムック) https://images-na.ssl-images-amazon.com/images/I/81kx4Dcvo4L._AC_UL160_SR160,160_.jpg 6 https://www.amazon.co.jp//OAD%E4%BB%98%E3%81%8D-%E8%BB%A2%E7%94%9F%E3%81%97%E3%81%9F%E3%82%89%E3%82%B9%E3%83%A9%E3%82%A4%E3%83%A0%E3%81%A0%E3%81%A3%E3%81%9F%E4%BB%B6-12-%E9%99%90%E5%AE%9A%E7%89%88-%E8%AC%9B%E8%AB%87%E7%A4%BE%E3%82%AD%E3%83%A3%E3%83%A9%E3%82%AF%E3%82%BF%E3%83%BC%E3%82%BA%E3%83%A9%E3%82%A4%E3%83%84/dp/406513935X?_encoding=UTF8&psc=1 OAD付き 転生したらスライムだった件(12)限 定版 (講談社キャラクターズライツ) https://images-na.ssl-images-amazon.com/images/I/51xlRxe7ykL._AC_UL160_SR160,160_.jpg 7 https://www.amazon.co.jp//1%E6%97%A53%E5%88%86%E8%A6%8B%E3%82%8B%E3%81%A0%E3%81%91%E3%81%A7%E3%81%90%E3%82%93%E3%81%90%E3%82%93%E7%9B%AE%E3%81%8C%E3%82%88%E3%81%8F%E3%81%AA%E3%82%8B-%E3%82%AC%E3%83%9C%E3%83%BC%E3%83%AB%E3%83%BB%E3%82%A2%E3%82%A4-%E5%B9%B3%E6%9D%BE-%E9%A1%9E/dp/4797399694?_encoding=UTF8&psc=1 1日3分見るだけでぐんぐん目がよくなる! ガボール・アイ https://images-na.ssl-images-amazon.com/images/I/71k2FysEGIL._AC_UL160_SR160,160_.jpg 8 https://www.amazon.co.jp//%E6%97%A5%E5%90%91%E5%9D%8246-1st%E3%82%B0%E3%83%AB%E3%83%BC%E3%83%97%E5%86%99%E7%9C%9F%E9%9B%86%E3%80%8E%E3%82%BF%E3%82%A4%E3%83%88%E3%83%AB%E6%9C%AA%E5%AE%9A%E3%80%8F/dp/4103527811?_encoding=UTF8&psc=1 日向坂46 1stグループ写真集 『タイトル未定』 https://images-na.ssl-images-amazon.com/images/I/911IeCcqO8L._AC_UL160_SR160,107_.jpg 9 https://www.amazon.co.jp//%E6%98%9F%E9%87%8E%E6%BA%90-%E3%81%B5%E3%81%9F%E3%82%8A%E3%81%8D%E3%82%8A%E3%81%A7%E8%A9%B1%E3%81%9D%E3%81%86-AERA%E3%83%A0%E3%83%83%E3%82%AF/dp/4022792337?_encoding=UTF8&psc=1 星野源 ふたりきりで話そう (AERAムック) https://images-na.ssl-images-amazon.com/images/I/61RXvslphbL._AC_UL160_SR160,160_.jpg 10 https://www.amazon.co.jp//%E3%83%8B%E3%83%A5%E3%83%BC%E3%82%BF%E3%82%A4%E3%83%97%E3%81%AE%E6%99%82%E4%BB%A3-%E6%96%B0%E6%99%82%E4%BB%A3%E3%82%92%E7%94%9F%E3%81%8D%E6%8A%9C%E3%81%8F24%E3%81%AE%E6%80%9D%E8%80%83%E3%83%BB%E8%A1%8C%E5%8B%95%E6%A7%98%E5%BC%8F-%E5%B1%B1%E5%8F%A3-%E5%91%A8/dp/447810834X?_encoding=UTF8&psc=1 ニュータイプの時代 新時代を生き抜く24の思考・行動様式 https://images-na.ssl-images-amazon.com/images/I/81bUaj2cn%2BL._AC_UL160_SR160,160_.jpg動的生成されるコンテンツへの対応(日刊スポーツ)

だいたいのサイトは上記のやり方でスクレーピングできますが、動的に生成されるコンテンツがあるサイトはSeleniumのheadlessブラウザを利用することで、動的に生成されたコンテンツを取得することができます。

以下のような、ただURLをダンプするだけのプログラムを作っておくと便利です(ここだけrubyですが、訳は聞かないでください。。。)

※あらかじめLinux版のgoogle-chromeとchromedriverの準備が必要となります。chrome_helper.rbrequire 'selenium-webdriver' url = ARGV[0] out = ARGV[1] ua = "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_8_4) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/27.0.1453.116 Safari/537.36" caps = Selenium::WebDriver::Remote::Capabilities.chrome("chromeOptions" => {binary: '/usr/bin/google-chrome', args: ["--headless", "--disable-gpu", "--user-agent=#{ua}", "window-size=1280x800"]}) $driver = Selenium::WebDriver.for :chrome, desired_capabilities: caps $driver.manage.timeouts.implicit_wait = 30 $driver.get url html = $driver.page_source File.open(out, "w") do |text| text.puts(html) end日刊スポーツのサイトを例にとると以下のようになります。

nikkan.pyimport sys,os import requests import bs4 import lxml.html import shutil fpath = /tmp/hoge.tsv url = 'https://www.nikkansports.com/ranking/#total' url_base = '' ### use chromedriver tmp = "nikkan.tmp" os.system(f"ruby chrome_helper.rb {url} {tmp}") f = open(tmp) content = f.read() html = lxml.html.fromstring(content) ## あとはいつもの f = open(fpath, mode="w"); for i in range(1,11): xpath = f'//*[@id="sougou"]/ul/li[{i}]/a' xpath2 = f'//*[@id="sougou"]/ul/li[{i}]/a/text()' xpath3 = f'//*[@id="sougou"]/ul/li[{i}]/a/img' link = html.xpath(xpath) link2 = html.xpath(xpath2) link3 = html.xpath(xpath3) href = link[0].get("href") text = link2[0] image = link3[0].get("style") image = image.replace("background-image: url(", "").replace(");", "") # 余計なスタイルシート指定を削除 f.write(f'{i} {url_base}{href} {text} {image}\n') f.close()ログインが必要なコンテンツへの対応

Seleniumを使うことによりログインが必要なコンテンツへのアクセスも容易に行えます。

以下の記事が参考になります。

Seleniumでログインを含めてWebスクレイピングしてみたhttps://qiita.com/cheekykorkind/items/efec86759073bf3f72e9

Python + Selenium + Chrome で自動ログインいくつかhttps://qiita.com/memakura/items/dbe7f6edadd456da1c5d

- 投稿日:2019-07-11T16:08:05+09:00

【日記】pythonでせっかくテストコードを書いたのでカバレッジも計測してみる

私が現在開発しているプロジェクトでは、かなりしっかりとテストコードを書いています。

ここまでしっかりとしたテストコードを書いたんなら、カバレッジとやらもかなりイイ感じになってんじゃね?と思い、今まで計測したことのないカバレッジを見てみることにしました。私はテストコードを書くために

unittestを使用しています。

unittest --- ユニットテストフレームワークしかし、これだけではカバレッジを計測することはできません。

カバレッジを計測するためには別のパッケージが必要です。

今回はその名もずばりcoverageというパッケージを使いました。

Coverage.pyこちらは、私が理解できた範囲では、

python3 hoge.pyのようにcoverage hoge.pyと実行すると、そのとき通ったコードの割合を記録してくれるという使い方をするカバレッジ測定ツールのようです。開発しているプロジェクトを普通に

py main.pyと実行しただけでは当然全てのコードを通ることはありません。

従って、ユニットテストを実行するときにこのcoverageを利用してみましょう。

すなわち、いつもはこんな感じでテストをしていたところを↓ターミナル.> py -m unittest discover code.unit_tests次のように変更するのです↓

ターミナル.> coverage run -m unittest discover code.unit_testsこのようにして実行し、記録して、そのあともう一度コマンドを実行して結果を表示します。

ターミナル.> coverage report -m実際に下記のようにカバレッジを測定することができました。

やった~!カバレッジの計測できたよ~! pic.twitter.com/L2Tz6n03Hj

— ヒト?♀️速バラ撒きおじさん/あつし (@Anaakikutsushit) July 11, 2019割と注意深くテストを書いていたつもりだったんですが、一か所だけカバレッジが6割弱のモジュールがありますね。発見出来てよかった。

今日はこんなところで。

- 投稿日:2019-07-11T15:53:52+09:00

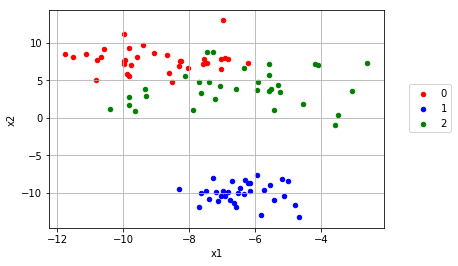

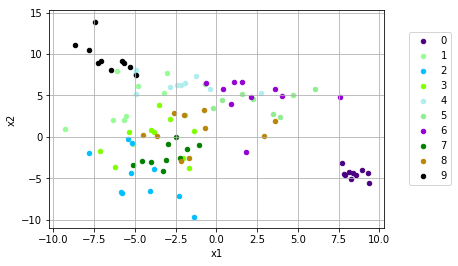

ロジスティック回帰を多クラス分類に

はじめに

これは筆者の勉強まとめページですので、指摘しまくってい頂けると幸いです

ロジスティック回帰を多クラス分類に持ち込む

https://qiita.com/raso0527/items/266714c5661e8376c04a

ロジスティック回帰は上記のページでTensorFlowを用いて実装しました

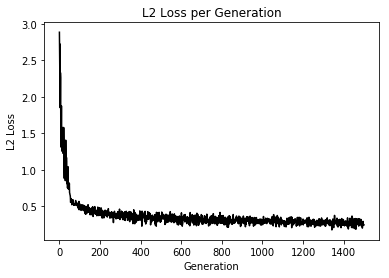

これを多クラス分類に使用してみます損失関数自体は変化しませんが、正解データの構造が少しだけ変化します

1クラス分類では、setosaとversicolorに対して1というデータ、virginicaには0というデータを与え、Sigmoid関数の出力の値がこの値に近づくようにパラメータを学習しました

今回は、[setosa] = [1, 0, 0], [versicolor] = [0, 1, 0], [virginica] = [0, 0, 1] とワンホットベクトルと呼ばれるものに正解データを変換します

以下がコードになります

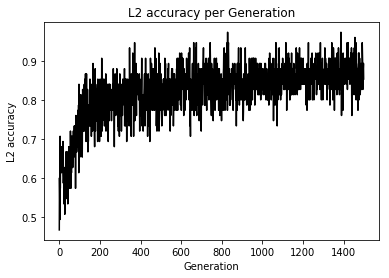

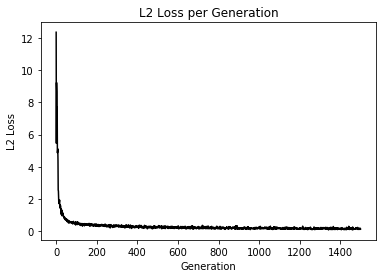

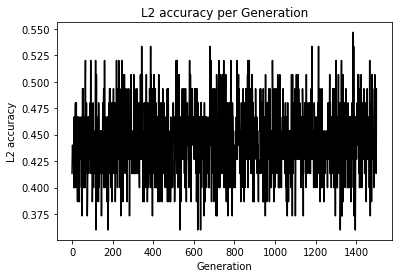

import matplotlib.pyplot as plt import tensorflow as tf import numpy as np from sklearn import datasets # シード値を固定して実行の度に同じ乱数が発生するようにしている tf.set_random_seed(1000) np.random.seed(1000) sess = tf.Session() # setosa, versicolor, virginicaの分類を行う iris = datasets.load_iris() x_vals = iris.data target = iris.target # ワンホットベクトルの作成 y1 = [[1, 0, 0] for i in target if i == 0] y2 = [[0, 1, 0] for i in target if i == 1] y3 = [[0, 0, 1] for i in target if i == 2] y_vals = np.array(y1+y2+y3) learning_rate = 0.05 batch_size = 25 x_data = tf.placeholder(shape = [None, 4], dtype = tf.float32) y_target = tf.placeholder(shape = [None, 3], dtype = tf.float32) A = tf.Variable(tf.random_normal(shape = [4, 3])) b = tf.Variable(tf.random_normal(shape = [3])) model_output = tf.add(tf.matmul(x_data, A), b) loss = tf.reduce_mean(tf.nn.sigmoid_cross_entropy_with_logits(logits = model_output, labels = y_target)) # loss = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits(logits = model_output, labels = y_target)) init = tf.global_variables_initializer() sess.run(init) optimizer = tf.train.GradientDescentOptimizer(learning_rate) train = optimizer.minimize(loss) prediction = tf.round(tf.sigmoid(model_output)) prediction_correct = tf.cast(tf.equal(prediction, y_target), tf.float32) accuracy = tf.reduce_mean(prediction_correct) loss_vec = [] accuracy_vec = [] for i in range(1500): rand_index = np.random.choice(len(x_vals), size = batch_size) rand_x = x_vals[rand_index] rand_y = y_vals[rand_index] sess.run(train, feed_dict = {x_data: rand_x, y_target: rand_y}) tmp_accuracy, temp_loss = sess.run([accuracy, loss], feed_dict = {x_data: rand_x, y_target: rand_y}) loss_vec.append(temp_loss) accuracy_vec.append(tmp_accuracy) if (i + 1) % 25 == 0: print("Step #" + str(i + 1) + " A = " + str(sess.run(A)) + " b = " + str(sess.run(b))) print("Loss = " + str(temp_loss)) print("Acc = " + str(tmp_accuracy)) plt.plot(loss_vec, "k-") plt.title("Loss per Generation") plt.xlabel("Generation") plt.ylabel("Loss") plt.show() plt.plot(accuracy_vec, "k-") plt.title("Accuracy per Generation") plt.xlabel("Generation") plt.ylabel("Accuracy") plt.show()Loss値とAccuracyの変化

うん、学習はしているけど今回もテスト検証めんどくちゃかったのでしてません、ごめんなちゃい

てか、これってSoftmaxCrossEntropyとどっちが評価として良いのかなあと思い損失関数を変化させ実験

Loss値とAccuracyの変化

え、めっちゃ差が出てるんだけど...

追加学習して変化をもう一度みてみようやはり変化なしでした

初期値やデータにも依存するのかな?

こんなに顕著に変化に現れると思いませんでしたってのが今回の感想です

- 投稿日:2019-07-11T15:34:02+09:00

『Yukarinライブラリ』become-yukarin, yukarin コマンド解説(我流ノウハウ付)

概要

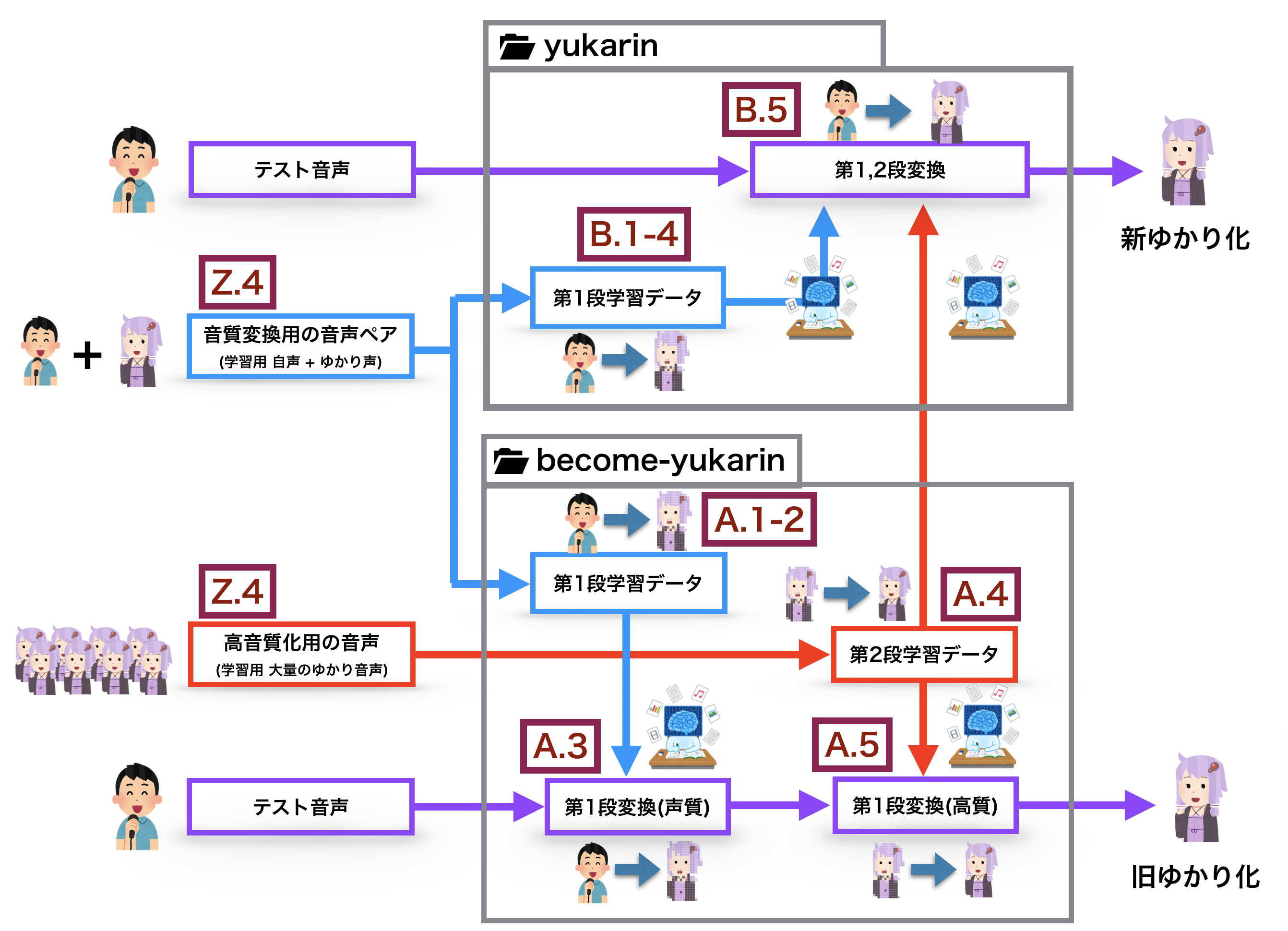

『Yukarinライブラリ』yukarin, become-yukarin リポジトリで、自分の音声をターゲット音声に変換する手順を紹介する。

yukarin は become-yukarin の改良版リポジトリであるが、2019/06/24 現在、become-yukarin での学習データを必要が必要になる。

よって、冗長となるが、 become-yukarin, yukarin 両方のコマンド解説を行う。前提として『Yukarinライブラリ』 yukarin, become-yukarin 概要・リポジトリ関係を整理してみたを把握しているものとします。

◾️ Yukarinライブラリとは?

『自分の声(自声)』を 『好きな音声(ターゲットボイス)』に 1対1 対応で音質変換をする OSS です。

yukarin, become-yukarin ではオフラインでの音声変換しかできませんが、学習データを realtime-yukain で実行することで、リアルタイム変換することもできます。詳細は下記を参照ください。

- 製作者のヒホ様の動画 : ディープラーニングの力で結月ゆかりの声になってみた

- 製作者のヒホ様のブログ: ディープラーニングの力で結月ゆかりの声になってみた

- まとめ情報記事 : ディープラーニング声質変換OSS「誰でも好きなキャラの声になれる」レポジトリ become-yukarinなどの関連記事等一覧◾️ 用語

Yukarinライブラリ

『yukarin』 と 『become-yukarin』の 2つをひっくるめて『Yukarinライブラリ』と命名されています。

- Hiroshiba/yukarin : 誰でも好きなキャラの声になれるリポジトリ』

- Hiroshiba/become-yukarin : 旧名は『ディープラーニングの力で誰でも結月ゆかりになれるリポジトリ』

"ゆかり音声"

ターゲット音声は任意ですが、イメージしやすいように 『ターゲット音声 = 結月ゆかり』と仮定します。

よって、"ターゲット音声"を"ゆかり音声"と表現します。◾️ GPU は何がいいの?

- realtime-yukarin を使う: GTX 1060(6G) 以上(readmeより)

- ただ変換するだけ: GTX 970(4G) 以上(become-yukarinの第2段では GPUメモリが 4G必要)

- 個人的なおすすめ : GTX 1070(8G) 中古(安くて・そこそこ早くて、GPUメモリが 8Gある)

◾️ 環境構築方法

・ Ubuntu v19.04 (RTX対応)

・ Ubuntu v18.10 LTS : @sakamotothogo 様◾️ 知っていると便利な知識

- git : リポジトリの更新を簡単に反映されるので強く推奨

- PyCharm コミュニティ版(無料) : Python・機械学習を勉強するなら強く推奨

◾️ エラーなどで困った時は?

- 気軽にコメントに書いてください!

- 『Yukarinライブラリ』 become-yukarin, yukarin のトラブルシューティング を見てみる

- yukarinコマンドジェネレーター! も参考になります

◾️ 目次

Z. become-yukarin, yukarin共通の事前作業

- Z.0 念のためのソフトインストール

- Z.1 ディレクトリ作成

- Z.2 各種リポジトリの取得

- Z.3 念のためのソフトインストール

- Z.4 音声データの収録

- Z.5 音声データの配置とリサンプリング

- Z.6 うっかり削除対策・バックアップ

- Z.7 環境変数の設定

- Z.8 ライブラリのインストール

A. become-yukarin

- A.1 音声変換のための特徴量抽出

- A.2 第1段の学習

- A.3 第1段を使った音声変換

- A.4 第2段の学習

- A.5 第2段を使った音質向上

B. yukarin

- B.1 音声変換のための特徴量抽出

- B.2 音響特徴量のアライメント

- B.3 周波数の統計量を求める

- B.4 第1段学習

- B.5 yukarin での音声変換

Z. become-yukarin, yukarin共通の事前作業

Z.0 念のためのソフトインストール

念のため ffmpeg, sox をインストールコマンドを実行してください。

コマンド(Ubuntu)

sudo apt install tree sudo apt install ffmpeg sudo apt install soxZ.1 ディレクトリ作成

作業ディレクトリを決定する

任意で構いませんが、後でディレクトリ移動させると環境変数の書き換えが必要となるので、気をつけてください。

この記事では HOME 直下の deep_yukarin ディレクトリで作業をすると仮定します。

以下で説明する各種コマンドはdeep_yukarin直下で、実行すると想定しています。mkdir ~/deep_yukarin cd deep_yukarinディレクトリ作成

本記事では以下のディレクトリ構造を前提にコマンド解説します。

リポジトリの相関や音声データの依存関係を考慮して、独断と偏見で決めてました。

作業ディレクトリに移動したあと、下記コマンドをコピペで実行してください。コマンド

mkdir dat mkdir dat/1st_models_by mkdir dat/2nd_models_by mkdir dat/1st_models_y mkdir dat/1st_models_by/yukari mkdir dat/1st_models_by/yukari/npy_pair mkdir dat/2nd_models_by/yukari mkdir dat/1st_models_y/yukari mkdir dat/1st_models_y/yukari/aligned_indexes mkdir dat/1st_models_y/yukari/aligned_wav mkdir dat/1st_models_y/yukari/statistics mkdir dat/1st_models_y/yukari/npy_pair mkdir dat/input mkdir dat/output mkdir dat/voice_src mkdir dat/voice_src/voice_24000 mkdir dat/voice_src/voice_44100 mkdir dat/voice_src/voice_24000/yukari_pair mkdir dat/voice_src/voice_24000/yukari_pair/own mkdir dat/voice_src/voice_24000/yukari_pair/target mkdir dat/voice_src/voice_24000/yukari_single mkdir dat/voice_src/voice_44100/yukari_pair mkdir dat/voice_src/voice_44100/yukari_pair/own mkdir dat/voice_src/voice_44100/yukari_pair/target mkdir dat/voice_src/voice_44100/yukari_singleチェック

tree コマンドで下記のようになっているか確認してください。tree dat dat ├── 1st_models_by │ └── yukari ├── 1st_models_y │ └── yukari ├── 2nd_models_by │ └── yukari ├── input ├── output └── voice_src ├── voice_24000 │ ├── yukari_pair │ │ ├── own │ │ └── target │ └── yukari_single └── voice_44100 ├── yukari_pair │ ├── own │ └── target └── yukari_singleZ.2 各種リポジトリの取得

- yukarin

- become-yukarin

- 筆者自作のチェックツール

- 日本声優統計学会の音素バランス文 を git で取得します。

* git を使わずサイトからダウンロードでもいいが、更新があった場合修正が面倒です。

* 筆者のチェックツールは必須ではありませんが、あること前提で解説します。コマンド

git clone https://github.com/Hiroshiba/become-yukarin git clone https://github.com/Hiroshiba/yukarin git clone git@bitbucket.org:YoshikazuOota/yukarin-tools.git git clone git@github.com:YoshikazuOota/balance_sentences.gitチェック

tree -L 1 . ├── balance_sentences ├── become-yukarin ├── dat ├── yukarin └── yukarin-tools補足: 各種リポジトリを最新版を反映する場合

yukarin, become-yukarin 等の各種のディレクトリに移動して、git pullを実行するcd ~/deep_yukarin cd [yukarin, become-yukarin] git pullさらに yukarin-tools 用に下記コマンドを実行してください。

sudo apt install node sudo apt install lm-sensors cd yukarin-tools npm install cd ~/deep_yukarinZ.4 音声データの収録

Z.4.1 音声データ作成におすすめする"音素バランス文"

CC BY-SA 4.0で公開されている、日本声優統計学会の音素バランス文がおすすめです。

balance_sentences/balance_sentences.txtに読み上げ文がありますので、必要に応じて利用してください。利用の際には 日本声優統計学会 から継承されている CC BY-SA 4.0 にしたがってください。

Z.4.2 第1段のゆかり・自声の収録

下記動画を参照してください。

これは一例であってベストってわけではありませんYukarinライブラリ用の音声収録方法の紹介

収録は 44100Hz / 16bit で行なっていますが、学習時には 24000Hz / 16bit にリサンプリングします。

(後々、高いサンプリングで学習したい場合があるかもしれないので、収録時は高サンプリングでいいと思います)ごめんなさい!

以前の記事では、『voiceroid2 などは 44100Hzがデフォルトなので、44100Hz で音声変換すればいい』と、書きましたがあまり適切では無いようです。

人間の音声はほぼ 10000Hz 以下に収まるそうなので、 学習音声のサンプリングはデフォルトの 24000Hzで良さそうです。

(シャノンのサンプリング定義より、24000Hz でサンプリングすれば 12000Hz 以下の音声解析ができます)Z.4.3 第2段のゆかりボイスの生成

自分は第1段で使ったゆかりボイス + 自分の動画で使った調教済み音声を使用しました(約2時間)。

ヒホ様の issueによると『私はJNASを読ませたものを用いました。』とのことです(約60時間)。

経験則的では、大量にボイスを用意すれば、内容は適当で良さそうです(違ったらごめんなさい)。Z.5 音声データの配置とリサンプリング

Z.5.1 音声データの配置

Z.4 で収録した音声データをそれぞれ下記のディレクトリに配置してください

- dat/voice_src/voice_44100/yukari_pair/own : Z.4 で収録した第1段の自声

- dat/voice_src/voice_44100/yukari_pair/target : Z.4 で生成した第1段のゆかり音声

- dat/voice_src/voice_44100/yukari_single : Z.4 で生成した第2段のゆかり音声

Z.5.2 ファイル数チェック(チェックサム)

下記の2ディレクトリには、同じ名前で同数のファイルを設置する必要があります。

- dat/voice_src/voice_44100/yukari_pair/own : Z.4 で収録した第1段の自声

- dat/voice_src/voice_44100/yukari_pair/target : Z.4 で生成した第1段のゆかり音声

手戻りが無いように下記コマンドで、ファイル数をチェックします。

./yukarin-tools/count_checker.js -b dat/voice_src/voice_44100/yukari_pair/own -d dat/voice_src/voice_44100/yukari_pair/targetZ.5.3 フォーマットチェック

自作ツールで、wav ファイルのフォーマットをチェックします。

-sでチェックするサンプリングレートを指定します./yukarin-tools/format_checker.js dat/voice_src/voice_44100/yukari_pair/own -s 44100 ./yukarin-tools/format_checker.js dat/voice_src/voice_44100/yukari_pair/target -s 44100 ./yukarin-tools/format_checker.js dat/voice_src/voice_44100/yukari_single -s 44100問題がなければ下記のようなメッセージが表示されます。

./yukarin-tools/format_checker.js dat/voice_src/voice_44100/yukari_single -s 44100 debug : {"src":"dat/voice_src/voice_44100/yukari_pair/own","sampling":44100} all files format : > channels : 1 > bits per sample : 16 > encoding : Signed Integer PCM > sampling : 44100 result : OKZ.5.4 リサンプリング

収録音声を Yukarinライブラリのデフォルトフォーマット 24000Hz /16 bit に変換します。

-bサンプリングする元データディレクトリ-dサンプリングしたデータを入れるディレクトリ(念の為、上書きできないようにしています)-sでチェックするサンプリングレートを指定します./yukarin-tools/resampling.js -b dat/voice_src/voice_44100/yukari_pair/own -d dat/voice_src/voice_24000/yukari_pair/own -s 24000 ./yukarin-tools/resampling.js -b dat/voice_src/voice_44100/yukari_pair/target -d dat/voice_src/voice_24000/yukari_pair/target -s 24000 ./yukarin-tools/resampling.js -b dat/voice_src/voice_44100/yukari_single -d dat/voice_src/voice_24000/yukari_single -s 24000自声(own)のリサンプリングで下記のような Warnが出るかもしれません。

これは、『ボリュームMAX超えているのがあるけどええんか?』的な、注意です。

アラートで、5 samplesの部分が100 samplesとか大きな数字になっていなければ、大丈夫です。sox WARN rate: rate clipped 5 samples; decrease volume? sox WARN dither: dither clipped 5 samples; decrease volume?Z.5.5 リサンプリングのチェック

しつこいですが、リサンプリング結果をチェックします。

./yukarin-tools/format_checker.js dat/voice_src/voice_24000/yukari_pair/own -s 24000 ./yukarin-tools/format_checker.js dat/voice_src/voice_24000/yukari_pair/target -s 24000 ./yukarin-tools/format_checker.js dat/voice_src/voice_24000/yukari_single -s 24000Z.6 うっかり削除対策・バックアップ

収録音声など、せっかく作った音声データを削除してしまわないように、データをリードオンリーにします。

念の為、別ストレージへバックアップもおすすめします。chmod -R 555 dat/voice_src書き込みできるように戻す場合は下記コマンドを実行してください

chmod -R 755 dat/voice_srcZ.7 環境変数の設定

emacs, vim 等で

~/.bashrcを開き、下記の一行を付け加えてください。

[user_name]の箇所は、アカウントに応じて適宜変更してください。export PYTHONPATH=/home/[user_name]/deep_yukarin/become-yukarin:/home/[user_name]/deep_yukarin/yukarin修正後、下記コマンドを実行してください。

このコマンドを実行しないと上記修正が反映されません。source ~/.bashrc下記コマンドで、先ほどの設定が表示されるか確認してください。

echo $PYTHONPATH > /home/[user_name]/deep_yukarin/become-yukarin:/home/[user_name]/deep_yukarin/yukarinZ.8 ライブラリのインストール

yukarin, become-yukarin に必要なライブラリをインストールします。

pip install -r become-yukarin/requirements.txt pip install world4py pip install -r yukarin/requiremets.txt* yukarin のライブラリインストールで、CUDA周りの再インストールされます。

A become-yukarin

A.1 音声変換のための特徴量抽出

become-yukarin の第1段の学習モデル作成は主に

dat/1st_models_by/yukarinで作業をします。

第1段の音声ファイルは少ないので、コピーして使うことにします。cp -r dat/voice_src/voice_24000/yukari_pair dat/1st_models_by/yukari/voice_pairコピーした音声ファイルから、音声の特徴量を抽出します。

(オプションの解説はしません。各種コマンドオプションは-hを付けて確認してください。 (expython become-yukarin/scripts/extract_acoustic_feature_arg -h)python become-yukarin/scripts/extract_acoustic_feature.py \ -i1 dat/1st_models_by/yukari/voice_pair/own \ -i2 dat/1st_models_by/yukari/voice_pair/target \ -o1 dat/1st_models_by/yukari/npy_pair/own \ -o2 dat/1st_models_by/yukari/npy_pair/target念の為、生成した npyファイルのチェックサムをとる。

./tools/count_checker.js -b dat/1st_models_by/yukari/voice_pair/target -d dat/1st_models_by/yukari/npy_pair/targetA.2 第1段の学習(become-yukarin)

学習前に設定ファイルをコピーして書き換えます。

cp become-yukarin/recipe/config.json dat/1st_models_by/yukari/エディタで config.json を開き

emacs dat/1st_models_by/yukari/config.json下記の6行を、書き換えてください。

その際、input_glob,target_glob音声収録をした時のプリフィックス "v-" などを忘れずにしてください。"input_glob": "dat/1st_models_by/yukari/npy_pair/own/v-*.npy", "input_mean_path": "dat/1st_models_by/yukari/npy_pair/own/mean.npy", "input_var_path": "dat/1st_models_by/yukari/npy_pair/own/var.npy", "target_glob": "dat/1st_models_by/yukari/npy_pair/target/v_*.npy", "target_mean_path": "ddat/1st_models_by/yukari/npy_pair/target/mean.npy", "target_var_path": "dat/1st_models_by/yukari/npy_pair/target/var.npy",さらに、GPUを使いための下記の設定をしてください。(cpu -1, gpu 0)

"gpu": 0,設定が終わったら、下記コマンドで学習を行います。

python become-yukarin/train.py dat/1st_models_by/yukari/config.json dat/1st_models_by/yukari/1st_yukari_model_byエラーがなければ、predictor_XXXX.npz と言う学習済みファイルが生成されます。

predictor_250000.npz 程度が出力されるのを待ちます(GTX 1070で 7時間ぐらい)。進捗チェックコマンド

watch -n 60 ls -latr dat/1st_models_by/yukari/1st_yukari_model_by蛇足

CPU,GPUの温度は以下でチェックできます。

熱暴走にはお気をつけて! (筆者は2回、熱保護でPCをクラッシュさせました)./yukarin-tools/watch_temperature.shA.3 第1段を使った音声変換

音声変換に使う入力・出力ファイルを格納するディレクトリを作成します。

test_dataには Z.4.2 で作った学習データとは、違う自声の音声データ(24000Hz / 16bit)を配置します。mkdir ./test_data mkdir ./output mkdir ./output/1st_yukari_model_by次に、上手く学習できていそうなデータの目星を付けます。

ヒホ様は train.pyの学習数について #10 のように選んでいるそうです。以下の選び方は我流です。参考までの一例です!

下記で、 5000ステップごとのdiscriminator/accuracyとdiscriminator/lossを出力します./yukarin-tools/log2accuracy.js dat/1st_models_by/yukari/1st_yukari_model_by/logここで着目するのは

acc(discriminator/accuracy)とloss(discriminator/loss)です。

accは問題なければ、90% 〜 97% ぐらいまで上がります。

これが 80% 程度から上がっていなければ、学習用音声の質が悪いか、手順にミスがあるかと思います。経験則では下記のデータが変換精度が高かったです。

- イテレーションが少ない

-accが大きい

-lossが小さい下記の結果から、選ぶなら下記 3つほどが候補になります。

(学習回数のイテレーションは大きければ大きいほどいいと言うことはありません。過学習と言う精度が下がる現象が起こります。)

- 145000 :: train > acc : 0.95, loss 0.283 :: test > acc 0.53 ( 4:13:21)

- 180000 :: train > acc : 0.95, loss 0.273 :: test > acc 0.63 ( 5:14:42)

- 220000 :: train > acc : 0.96, loss 0.227 :: test > acc 0.52 ( 6:24:50)

{ acc: 0.85, skip: 5000, full: false, src: 'dat/1st_models_by/yukari/1st_yukari_model_by/log' } - 15000 :: train > acc : 0.86, loss 0.654 :: test > acc 0.53 ( 0:26:06) - 25000 :: train > acc : 0.87, loss 0.627 :: test > acc 0.67 ( 0:43:32) - 30000 :: train > acc : 0.88, loss 0.552 :: test > acc 0.48 ( 0:52:15) - 35000 :: train > acc : 0.89, loss 0.538 :: test > acc 0.66 ( 1:00:58) - 40000 :: train > acc : 0.89, loss 0.521 :: test > acc 0.55 ( 1:09:41) - 45000 :: train > acc : 0.90, loss 0.489 :: test > acc 0.58 ( 1:18:25) - 50000 :: train > acc : 0.90, loss 0.511 :: test > acc 0.56 ( 1:27:08) - 55000 :: train > acc : 0.89, loss 0.499 :: test > acc 0.53 ( 1:35:52) - 60000 :: train > acc : 0.91, loss 0.472 :: test > acc 0.70 ( 1:44:35) - 65000 :: train > acc : 0.90, loss 0.483 :: test > acc 0.66 ( 1:53:19) - 70000 :: train > acc : 0.89, loss 0.513 :: test > acc 0.63 ( 2:02:03) - 75000 :: train > acc : 0.90, loss 0.485 :: test > acc 0.58 ( 2:10:47) - 80000 :: train > acc : 0.91, loss 0.457 :: test > acc 0.55 ( 2:19:31) - 85000 :: train > acc : 0.90, loss 0.472 :: test > acc 0.52 ( 2:28:15) - 90000 :: train > acc : 0.91, loss 0.450 :: test > acc 0.59 ( 2:37:00) - 95000 :: train > acc : 0.89, loss 0.510 :: test > acc 0.50 ( 2:45:44) - 100000 :: train > acc : 0.91, loss 0.437 :: test > acc 0.70 ( 2:54:30) - 105000 :: train > acc : 0.90, loss 0.483 :: test > acc 0.61 ( 3:03:14) - 110000 :: train > acc : 0.91, loss 0.422 :: test > acc 0.63 ( 3:12:03) - 115000 :: train > acc : 0.92, loss 0.383 :: test > acc 0.64 ( 3:20:48) - 120000 :: train > acc : 0.91, loss 0.418 :: test > acc 0.58 ( 3:29:33) - 125000 :: train > acc : 0.92, loss 0.385 :: test > acc 0.41 ( 3:38:19) - 130000 :: train > acc : 0.93, loss 0.354 :: test > acc 0.39 ( 3:47:04) - 135000 :: train > acc : 0.94, loss 0.327 :: test > acc 0.58 ( 3:55:50) - 140000 :: train > acc : 0.92, loss 0.391 :: test > acc 0.61 ( 4:04:35) - 145000 :: train > acc : 0.95, loss 0.283 :: test > acc 0.53 ( 4:13:21) - 150000 :: train > acc : 0.93, loss 0.379 :: test > acc 0.45 ( 4:22:06) - 155000 :: train > acc : 0.94, loss 0.326 :: test > acc 0.41 ( 4:30:52) - 160000 :: train > acc : 0.94, loss 0.330 :: test > acc 0.58 ( 4:39:38) - 165000 :: train > acc : 0.93, loss 0.360 :: test > acc 0.50 ( 4:48:24) - 170000 :: train > acc : 0.93, loss 0.348 :: test > acc 0.64 ( 4:57:10) - 175000 :: train > acc : 0.94, loss 0.321 :: test > acc 0.58 ( 5:05:56) - 180000 :: train > acc : 0.95, loss 0.273 :: test > acc 0.63 ( 5:14:42) - 185000 :: train > acc : 0.94, loss 0.278 :: test > acc 0.72 ( 5:23:28) - 190000 :: train > acc : 0.94, loss 0.295 :: test > acc 0.64 ( 5:32:14) - 195000 :: train > acc : 0.94, loss 0.279 :: test > acc 0.66 ( 5:41:00) - 200000 :: train > acc : 0.94, loss 0.308 :: test > acc 0.50 ( 5:49:46) - 205000 :: train > acc : 0.95, loss 0.268 :: test > acc 0.69 ( 5:58:32) - 210000 :: train > acc : 0.93, loss 0.326 :: test > acc 0.56 ( 6:07:18) - 215000 :: train > acc : 0.94, loss 0.290 :: test > acc 0.64 ( 6:16:04) - 220000 :: train > acc : 0.96, loss 0.227 :: test > acc 0.52 ( 6:24:50) - 225000 :: train > acc : 0.95, loss 0.251 :: test > acc 0.59 ( 6:33:37) - 230000 :: train > acc : 0.96, loss 0.238 :: test > acc 0.72 ( 6:42:23) - 235000 :: train > acc : 0.96, loss 0.216 :: test > acc 0.53 ( 6:51:09) - 240000 :: train > acc : 0.95, loss 0.259 :: test > acc 0.55 ( 6:59:56) - 245000 :: train > acc : 0.96, loss 0.228 :: test > acc 0.70 ( 7:08:43) - 250000 :: train > acc : 0.95, loss 0.253 :: test > acc 0.67 ( 7:17:29)変換の実行は下記コマンドで実行します。

[イテレーション数] には 変換したい数字を入れてください。python become-yukarin/scripts/voice_conversion_test.py 1st_yukari_model_by \ -iwd dat/1st_models_by/yukari/voice_pair/own \ -md dat/1st_models_by/yukari \ -it [イテレーション数]変換結果は

output/1st_yukari_model_byに保存されます。

成功した場合

inputディレクトリの音声変換結果dat/1st_models_by/yukari/voice_pair/ownからランダムに選ばれた音声変換結果が入っています。

筆者の変換結果(葵音声)

個人的には predictor_145000.npz が一番いい様に思います。

ちなみに、ヒホ様のデモでは 19万 イテレーションの学習データを使用したそうです(train.pyの学習数について)。

あと、理屈はわかりませんが、音声の後半にノイズ入ります。変換前データの後方の無音時間をカットすれば問題ないと思います。

- predictor_95000.npz

- predictor_145000.npz

- predictor_180000.npz

- predictor_220000.npz

- predictor_235000.npz

A.4 第2段学習

voice ソース から直接参照して(データ数が多いのでコピーしません)、音声特徴量を抽出します。

python become-yukarin/scripts/extract_spectrogram_pair.py \ -i dat/voice_src/voice_24000/yukari_single \ -o dat/2nd_models_by/yukari/npy_single

LLVM ERROR: out of memory等で、出てハングアップすることがあります。

その時はctrl + cで処理を中断して、、2回、3回と繰り返すことで、全ての音声を変換できると思います。変換後、下記コマンドで全ファイルが変換されているかチェックします。

数が合わなければ、上記処理を繰り返しましょう。./yukarin-tools/count_checker.js -b dat/2nd_models_by/yukari/npy_single -d dat/voice_src/voice_24000/yukari_singlecp become-yukarin/recipe/config_sr.json dat/2nd_models_by/yukari/A.2 同様に、config_sr.py をコピーして、データ置き、三行修正をします。

batchsizeは GPU Mem 4G なら 1, GPU Mem 8G なら 2"input_glob": "dat/2nd_models_by/yukari/npy_single/*.npy", "batchsize": 1 "gpu": 0,設定が終われば、下記コマンドで学習します。

こちらは、第1段に比べてかなりの時間がかかります。

自分は 100,000イテレーションほどのデータを使用していますが、どの程度が適切なのかはわかりません。python become-yukarin/train_sr.py \ dat/2nd_models_by/yukari/config_sr.json \ dat/2nd_models_by/yukari/2nd_yukari_model_by進捗チェックコマンド

watch -n 60 ls -latr dat/1st_models_by/yukari/2nd_yukari_model_byA.5 第2段を使った音質向上

A.3 で変換したデータを

test_data_srにコピーします。mkdir test_data_sr cp output/1st_yukari_model_by/* test_data_sr./yukarin-tools/format_checker.js dat/2nd_models_by/yukari/npy_single dat/voice_src/voice_24000/yukari_single

python become-yukarin/scripts/super_resolution_test.py 2nd_yukari_model_by/ \ -md dat/2nd_models_by/yukari \ -iwd dat/voice_src/voice_24000/yukari_single第2段のプレディクターは 2nd_yukari_model_by 内で一番、イテレーションが大きいものが使われます。

筆者の変換結果(葵音声)

predictor_145000.npz の第1段音声が割と綺麗に取れているので、差がわかりにくいですが、多少音質がよくなっていると思います。predictor_145000.npz の第1段に第2段を適用した音声

B. yukarin

yukarinって何が違うの?

現状では、基本リファクタリングがメインで、新規点は 声のピッチを調整が簡単になった とのことです。

また、音声変換の精度も少し変わるようです。B.1 音声変換のための特徴量抽出

ざっくり言うと、B.1, B.2 の処理は、A.1 を分割しているだけで処理内容はほとんど同じっぽいです。

A.1 同様音声ファイルはコピーして使います。

cp -r dat/voice_src/voice_24000/yukari_pair dat/1st_models_y/yukari/voice_pair自声の特徴量抽出

python yukarin/scripts/extract_acoustic_feature.py \ -i './dat/1st_models_y/yukari/voice_pair/own/*.wav' \ -o './dat/1st_models_y/yukari/npy_pair/own'注: readmeの * -> *.wav に変更しているのは安全のため

ゆかりの特徴量抽出

python yukarin/scripts/extract_acoustic_feature.py \ -i './dat/1st_models_y/yukari/voice_pair/target/*.wav' \ -o './dat/1st_models_y/yukari/npy_pair/target'npyのチェックサム

./yukarin-tools/count_checker.js -b dat/1st_models_y/yukari/npy_pair/own -d dat/1st_models_y/yukari/npy_pair/targetB.2 音響特徴量のアライメント

自声とゆかり音声の微妙なずれを補償する。

python yukarin/scripts/extract_align_indexes.py \ -i1 './dat/1st_models_y/yukari/npy_pair/own/*.npy' \ -i2 './dat/1st_models_y/yukari/npy_pair/target/*.npy' \ -o './dat/1st_models_y/yukari/aligned_indexes/'B.3 周波数の統計量を求める

声の高さの平均、分散を求める。

この平均値をいじることで、変換後の音声のピッチを調整できるようです。python yukarin/scripts/extract_f0_statistics.py\ -i './dat/1st_models_y/yukari/npy_pair/own/*.npy' \ -o './dat/1st_models_y/yukari/statistics/own.npy'python yukarin/scripts/extract_f0_statistics.py\ -i './dat/1st_models_y/yukari/npy_pair/target/*.npy' \ -o './dat/1st_models_y/yukari/statistics/target.npy'B.4 第1段学習(yukarin)

cp yukarin/sample_config.json ./dat/1st_models_y/yukari/config.jsonemacs dat/1st_models/config.json で編集

L15-17"input_glob": "./dat/1st_models_y/yukari/npy_pair/own/*.npy", "target_glob": "./dat/1st_models_y/yukari/npy_pair/target/*.npy", "indexes_glob": "./dat/1st_models_y/yukari/aligned_indexes/*.npy",python yukarin/train.py \ ./dat/1st_models_y/yukari/config.json \ ./dat/1st_models_y/yukari/1st_yukari_model_y学習進行チェックコマンド

watch -n 60 "pwd; ls -ltr dat/1st_models_y/yukari/1st_yukari_model_y"B.5 yukarin での音声変換(第1,2段)

become-yukarin で使用したテストデータを移動させます。

cp test_data/*.wav dat/input/A.3 同様に音質が良さそうな学習データをピックアップします。

./yukarin-tools/log2accuracy.js dat/1st_models_y/yukari/1st_yukari_model_y/logyukarinは become-yuakrin に比べて、

accが高めになりました。

- 120000 :: train > acc : 0.98, loss 0.121 :: test > acc 0.57 ( 3:36:31)

- 160000 :: train > acc : 0.98, loss 0.116 :: test > acc 0.57 ( 4:48:56)

- 210000 :: train > acc : 0.98, loss 0.107 :: test > acc 0.65 ( 6:19:33)

{ acc: 0.85, skip: 5000, full: false, src: 'dat/1st_models_y/yukari/1st_yukari_model_y/log' } - 5000 :: train > acc : 0.95, loss 0.379 :: test > acc 0.51 ( 0:09:00) - 10000 :: train > acc : 0.97, loss 0.232 :: test > acc 0.59 ( 0:18:01) - 15000 :: train > acc : 0.97, loss 0.200 :: test > acc 0.52 ( 0:27:03) - 20000 :: train > acc : 0.97, loss 0.199 :: test > acc 0.56 ( 0:36:03) - 25000 :: train > acc : 0.98, loss 0.170 :: test > acc 0.57 ( 0:45:04) - 30000 :: train > acc : 0.98, loss 0.164 :: test > acc 0.57 ( 0:54:05) - 35000 :: train > acc : 0.98, loss 0.155 :: test > acc 0.63 ( 1:03:07) - 40000 :: train > acc : 0.98, loss 0.157 :: test > acc 0.59 ( 1:12:09) - 45000 :: train > acc : 0.98, loss 0.158 :: test > acc 0.56 ( 1:21:09) - 50000 :: train > acc : 0.98, loss 0.152 :: test > acc 0.57 ( 1:30:09) - 55000 :: train > acc : 0.98, loss 0.146 :: test > acc 0.52 ( 1:39:10) - 60000 :: train > acc : 0.98, loss 0.153 :: test > acc 0.66 ( 1:48:11) - 65000 :: train > acc : 0.98, loss 0.143 :: test > acc 0.54 ( 1:57:11) - 70000 :: train > acc : 0.98, loss 0.147 :: test > acc 0.57 ( 2:06:13) - 75000 :: train > acc : 0.98, loss 0.137 :: test > acc 0.62 ( 2:15:15) - 80000 :: train > acc : 0.98, loss 0.140 :: test > acc 0.57 ( 2:24:16) - 85000 :: train > acc : 0.98, loss 0.142 :: test > acc 0.61 ( 2:33:18) - 90000 :: train > acc : 0.98, loss 0.137 :: test > acc 0.50 ( 2:42:20) - 95000 :: train > acc : 0.98, loss 0.133 :: test > acc 0.68 ( 2:51:22) - 100000 :: train > acc : 0.98, loss 0.138 :: test > acc 0.56 ( 3:00:23) - 105000 :: train > acc : 0.98, loss 0.145 :: test > acc 0.68 ( 3:09:25) - 110000 :: train > acc : 0.98, loss 0.132 :: test > acc 0.71 ( 3:18:27) - 115000 :: train > acc : 0.98, loss 0.152 :: test > acc 0.64 ( 3:27:29) - 120000 :: train > acc : 0.98, loss 0.121 :: test > acc 0.57 ( 3:36:31) - 125000 :: train > acc : 0.98, loss 0.113 :: test > acc 0.58 ( 3:45:35) - 130000 :: train > acc : 0.98, loss 0.136 :: test > acc 0.59 ( 3:54:38) - 135000 :: train > acc : 0.98, loss 0.130 :: test > acc 0.63 ( 4:03:41) - 140000 :: train > acc : 0.98, loss 0.123 :: test > acc 0.63 ( 4:12:45) - 145000 :: train > acc : 0.98, loss 0.123 :: test > acc 0.60 ( 4:21:48) - 150000 :: train > acc : 0.98, loss 0.131 :: test > acc 0.60 ( 4:30:51) - 155000 :: train > acc : 0.98, loss 0.110 :: test > acc 0.63 ( 4:39:53) - 160000 :: train > acc : 0.98, loss 0.116 :: test > acc 0.57 ( 4:48:56) - 165000 :: train > acc : 0.98, loss 0.139 :: test > acc 0.56 ( 4:57:59) - 170000 :: train > acc : 0.98, loss 0.121 :: test > acc 0.59 ( 5:07:01) - 175000 :: train > acc : 0.97, loss 0.205 :: test > acc 0.61 ( 5:16:05) - 180000 :: train > acc : 0.98, loss 0.112 :: test > acc 0.62 ( 5:25:08) - 185000 :: train > acc : 0.98, loss 0.119 :: test > acc 0.64 ( 5:34:12) - 190000 :: train > acc : 0.98, loss 0.136 :: test > acc 0.64 ( 5:43:15) - 195000 :: train > acc : 0.98, loss 0.116 :: test > acc 0.73 ( 5:52:19) - 200000 :: train > acc : 0.98, loss 0.109 :: test > acc 0.59 ( 6:01:23) - 205000 :: train > acc : 0.99, loss 0.104 :: test > acc 0.61 ( 6:10:28) - 210000 :: train > acc : 0.98, loss 0.107 :: test > acc 0.65 ( 6:19:33) - 215000 :: train > acc : 0.98, loss 0.110 :: test > acc 0.66 ( 6:28:38) - 220000 :: train > acc : 0.98, loss 0.114 :: test > acc 0.65 ( 6:37:42) - 225000 :: train > acc : 0.99, loss 0.107 :: test > acc 0.68 ( 6:46:46) - 230000 :: train > acc : 0.98, loss 0.108 :: test > acc 0.60 ( 6:55:51) - 235000 :: train > acc : 0.98, loss 0.108 :: test > acc 0.70 ( 7:04:54) - 240000 :: train > acc : 0.99, loss 0.110 :: test > acc 0.74 ( 7:13:58) - 245000 :: train > acc : 0.98, loss 0.107 :: test > acc 0.63 ( 7:23:03) - 250000 :: train > acc : 0.98, loss 0.108 :: test > acc変換候補イテレーション

- 120000 :: train > acc : 0.98, loss 0.121 :: test > acc 0.57 ( 3:36:31)

- 160000 :: train > acc : 0.98, loss 0.116 :: test > acc 0.57 ( 4:48:56)

- 210000 :: train > acc : 0.98, loss 0.107 :: test > acc 0.65 ( 6:19:33)

音声変換実行コマンド

コマンドが長くてわかりにくいですが,

[イテレーション数]は書き換えてくださいpython yukarin/scripts/voice_change.py \ --voice_changer_model_dir './dat/1st_models_y/yukari/1st_yukari_model_y' \ --voice_changer_config './dat/1st_models_y/yukari/1st_yukari_model_y/config.json' \ --voice_changer_model_iteration [イテレーション数] \ --super_resolution_model './dat/2nd_models_by/yukari/2nd_yukari_model_by/predictor_100000.npz' \ --super_resolution_config './dat/2nd_models_by/yukari/2nd_yukari_model_by/config.json' \ --input_statistics './dat/1st_models_y/yukari/statistics/own.npy' \ --target_statistics './dat/1st_models_y/yukari/statistics/target.npy' \ --out_sampling_rate 24000 \ --dataset_input_wave_dir './dat/1st_models_y/yukari/voice_pair/own' \ --dataset_target_wave_dir './dat/1st_models_y/yukari/voice_pair/target' \ --test_wave_dir './dat/input' \ --output_dir './dat/output' \ --gpu 0出力結果

第2段の学習モデルは A.5 と同じものを使用しています。

@AI_Kiritan 様の場合は、変換精度が向上しているようですが、自分はノイズが増えてしまいました。

手順は同じはずなので、学習用音声が yukarin のアルゴリズムにあっていないのかと思います(調査したいところです)。どんぐりの背比べですが、イテレーション 120000が一番良いかと思います。

自分の場合 サ行、タ行 の発話でノイズになりやすい様です。これは発話の癖なのでしょうか・・・?サ行の音は「歯擦音(しさつおん)」と呼ばれて、この音はプロのミキサーも、綺麗に聞こえる用に調整するのが難しいそうです。

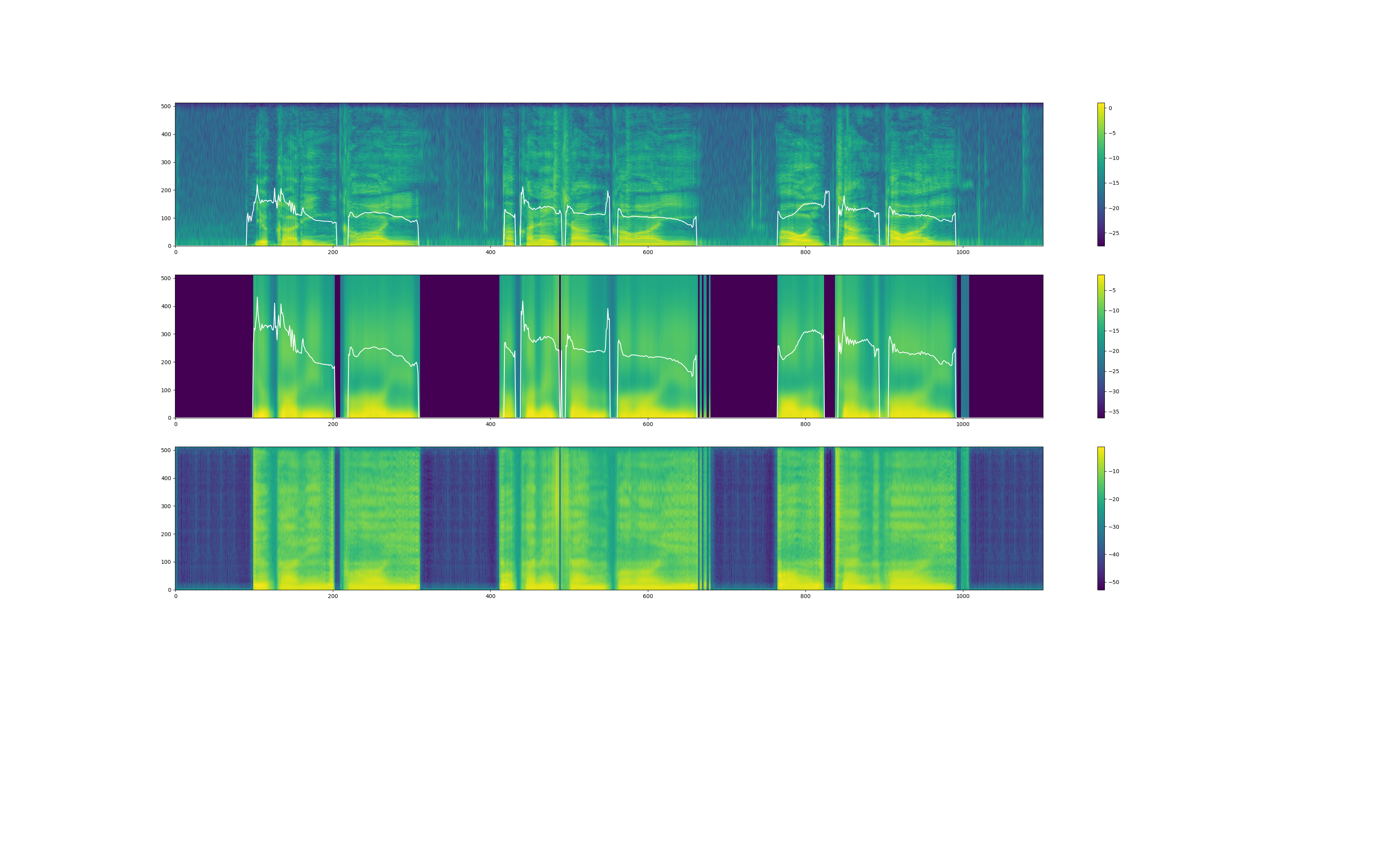

もしかして、音声変換もしにくい音なのかもしれません。また、yukarin の音声出力時には、変換音声の"スペクトラム" & "f0(基本周波数)" のプロットらしきものが出力されます(まだ詳しく見てないです)。

プロット図(yukarin_120000)

終わりに

realtime-yukarin は B.5 のコマンドと同じ要領で実行できます。(readmeを見るだけで済むと思うので、記事にしないと思います)

はやり、リアルタイムで音声変換するのは夢ですよね!よくわからないところが、あればコメントよろしくお願いします!

それでは、良い音声変換ライフを!

- 投稿日:2019-07-11T15:34:02+09:00

『Yukarinライブラリ』become-yukarin, yukarin コマンド解説

概要

『Yukarinライブラリ』yukarin, become-yukarin リポジトリで、自分の音声をターゲット音声に変換する手順を紹介する。

yukarin は become-yukarin の改良版リポジトリであるが、2019/06/24 現在、become-yukarin での学習データを必要が必要になる。

よって、冗長となるが、 become-yukarin, yukarin 両方のコマンド解説を行う。前提として『Yukarinライブラリ』 yukarin, become-yukarin 概要・リポジトリ関係を整理してみたを把握しているものとします。

◾️ Yukarinライブラリとは?

『自分の声(自声)』を 『好きな音声(ターゲットボイス)』に 1対1 対応で音質変換をする OSS です。

yukarin, become-yukarin ではオフラインでの音声変換しかできませんが、学習データを realtime-yukain で実行することで、リアルタイム変換することもできます。詳細は下記を参照ください。

- 製作者のヒホ様の動画 : ディープラーニングの力で結月ゆかりの声になってみた

- 製作者のヒホ様のブログ: ディープラーニングの力で結月ゆかりの声になってみた

- まとめ情報記事 : ディープラーニング声質変換OSS「誰でも好きなキャラの声になれる」レポジトリ become-yukarinなどの関連記事等一覧◾️ 用語

Yukarinライブラリ

『yukarin』 と 『become-yukarin』の 2つをひっくるめて『Yukarinライブラリ』と命名されています。

- Hiroshiba/yukarin : 誰でも好きなキャラの声になれるリポジトリ』

- Hiroshiba/become-yukarin : 旧名は『ディープラーニングの力で誰でも結月ゆかりになれるリポジトリ』

"ゆかり音声"

ターゲット音声は任意ですが、イメージしやすいように 『ターゲット音声 = 結月ゆかり』と仮定します。

よって、"ターゲット音声"を"ゆかり音声"と表現します。◾️ GPU は何がいいの?

- realtime-yukarin を使う: GTX 1060(6G) 以上(readmeより)

- ただ変換するだけ: GTX 970(4G) 以上(become-yukarinの第2段では GPUメモリが 4G必要)

- 個人的なおすすめ : GTX 1070(8G) 中古(安くて・そこそこ早くて、GPUメモリが 8Gある)

◾️ 環境構築方法

・ Ubuntu v19.04 (RTX対応)

・ Ubuntu v18.10 LTS : @sakamotothogo 様◾️ 知っていると便利な知識

- git : 簡単に最新リポジトリに更新できる

- PyCharm コミュニティ版(無料) : Python・機械学習を勉強するなら強く推奨

◾️ エラーなどで困った時は?

- 気軽にコメントに書いてください!

- 『Yukarinライブラリ』 become-yukarin, yukarin のトラブルシューティング を見てみる

- yukarinコマンドジェネレーター! も参考になります

◾️ 目次

Z. become-yukarin, yukarin共通の事前作業

- Z.0 念のためのソフトインストール

- Z.1 ディレクトリ作成

- Z.2 各種リポジトリの取得

- Z.3 念のためのソフトインストール

- Z.4 音声データの収録

- Z.5 音声データの配置とリサンプリング

- Z.6 うっかり削除対策・バックアップ

- Z.7 環境変数の設定

- Z.8 ライブラリのインストール

A. become-yukarin

- A.1 音声変換のための特徴量抽出

- A.2 第1段の学習

- A.3 第1段を使った音声変換

- A.4 第2段の学習

- A.5 第2段を使った音質向上

B. yukarin

- B.1 音声変換のための特徴量抽出

- B.2 音響特徴量のアライメント

- B.3 周波数の統計量を求める

- B.4 第1段学習

- B.5 yukarin での音声変換

Z. become-yukarin, yukarin共通の事前作業

Z.0 念のためのソフトインストール

ffmpeg, sox, tree をインストールコマンドを実行してください。

コマンド(Ubuntu)

sudo apt install tree sudo apt install ffmpeg sudo apt install soxZ.1 ディレクトリ作成

作業ディレクトリを決定する

任意で構いませんが、後でディレクトリ移動させると環境変数の書き換えが必要となるので、気をつけてください。

この記事では HOME 直下の deep_yukarin ディレクトリで作業をすると仮定します。

以下で説明する各種コマンドはdeep_yukarin直下で、実行すると想定しています。mkdir ~/deep_yukarin cd deep_yukarinディレクトリ作成

本記事では以下のディレクトリ構造を前提にコマンド解説します。

リポジトリの相関や音声データの依存関係を考慮して、独断と偏見で決めてました。

作業ディレクトリに移動したあと、下記コマンドをコピペで実行してください。コマンド

mkdir dat mkdir dat/1st_models_by mkdir dat/2nd_models_by mkdir dat/1st_models_y mkdir dat/1st_models_by/yukari mkdir dat/1st_models_by/yukari/npy_pair mkdir dat/2nd_models_by/yukari mkdir dat/1st_models_y/yukari mkdir dat/1st_models_y/yukari/aligned_indexes mkdir dat/1st_models_y/yukari/aligned_wav mkdir dat/1st_models_y/yukari/statistics mkdir dat/1st_models_y/yukari/npy_pair mkdir dat/input mkdir dat/output mkdir dat/voice_src mkdir dat/voice_src/voice_24000 mkdir dat/voice_src/voice_44100 mkdir dat/voice_src/voice_24000/yukari_pair mkdir dat/voice_src/voice_24000/yukari_pair/own mkdir dat/voice_src/voice_24000/yukari_pair/target mkdir dat/voice_src/voice_24000/yukari_single mkdir dat/voice_src/voice_44100/yukari_pair mkdir dat/voice_src/voice_44100/yukari_pair/own mkdir dat/voice_src/voice_44100/yukari_pair/target mkdir dat/voice_src/voice_44100/yukari_singleチェック

tree コマンドで下記のようになっているか確認してください。tree dat dat ├── 1st_models_by │ └── yukari ├── 1st_models_y │ └── yukari ├── 2nd_models_by │ └── yukari ├── input ├── output └── voice_src ├── voice_24000 │ ├── yukari_pair │ │ ├── own │ │ └── target │ └── yukari_single └── voice_44100 ├── yukari_pair │ ├── own │ └── target └── yukari_singleZ.2 各種リポジトリの取得

- yukarin

- become-yukarin

- 筆者自作のチェックツール

- 日本声優統計学会の音素バランス文 を git で取得します。

* git を使わずサイトからダウンロードでもいいが、更新があった場合修正が面倒です。

* 筆者のチェックツールは必須ではありませんが、あること前提で解説します。コマンド

git clone https://github.com/Hiroshiba/become-yukarin git clone https://github.com/Hiroshiba/yukarin git clone git@bitbucket.org:YoshikazuOota/yukarin-tools.git git clone git@github.com:YoshikazuOota/balance_sentences.gitチェック

tree -L 1 . ├── balance_sentences ├── become-yukarin ├── dat ├── yukarin └── yukarin-tools補足: 各種リポジトリを最新版を反映する場合

yukarin, become-yukarin 等の各種のディレクトリに移動して、git pullを実行するcd ~/deep_yukarin cd [yukarin, become-yukarin] git pullさらに yukarin-tools 用に下記コマンドを実行してください。

sudo apt install node sudo apt install lm-sensors cd yukarin-tools npm install cd ~/deep_yukarinZ.4 音声データの収録

Z.4.1 音声データ作成におすすめする"音素バランス文"

CC BY-SA 4.0で公開されている、日本声優統計学会の音素バランス文がおすすめです。

balance_sentences/balance_sentences.txtに読み上げ文がありますので、必要に応じて利用してください。利用の際には 日本声優統計学会 から継承されている CC BY-SA 4.0 にしたがってください。

Z.4.2 第1段のゆかり・自声の収録

下記動画を参照してください。

これは一例であってベストってわけではありませんYukarinライブラリ用の音声収録方法の紹介

収録は 44100Hz / 16bit で行なっていますが、学習時には 24000Hz / 16bit にリサンプリングします。

(後々、高いサンプリングで学習したい場合があるかもしれないので、収録時は高サンプリングでいいと思います)ごめんなさい!

以前の記事では、『voiceroid2 などは 44100Hzがデフォルトなので、44100Hz で音声変換すればいい』と、書きましたがあまり適切では無いようです。

人間の音声はほぼ 10000Hz 以下に収まるそうなので、 学習音声のサンプリングはデフォルトの 24000Hzで良さそうです。

(シャノンのサンプリング定義より、24000Hz でサンプリングすれば 12000Hz 以下の音声解析ができます)Z.4.3 第2段のゆかりボイスの生成

自分は第1段で使ったゆかりボイス + 自分の動画で使った調教済み音声を使用しました(約2時間)。

ヒホ様の issueによると『私はJNASを読ませたものを用いました。』とのことです(約60時間)。

経験則的では、大量にボイスを用意すれば、内容は適当で良さそうです(違ったらごめんなさい)。Z.5 音声データの配置とリサンプリング

Z.5.1 音声データの配置

Z.4 で収録した音声データをそれぞれ下記のディレクトリに配置してください

- dat/voice_src/voice_44100/yukari_pair/own : Z.4 で収録した第1段の自声

- dat/voice_src/voice_44100/yukari_pair/target : Z.4 で生成した第1段のゆかり音声

- dat/voice_src/voice_44100/yukari_single : Z.4 で生成した第2段のゆかり音声

Z.5.2 ファイル数チェック(チェックサム)

下記の2ディレクトリには、同じ名前で同数のファイルを設置する必要があります。

- dat/voice_src/voice_44100/yukari_pair/own : Z.4 で収録した第1段の自声

- dat/voice_src/voice_44100/yukari_pair/target : Z.4 で生成した第1段のゆかり音声

手戻りが無いように下記コマンドで、ファイル数をチェックします。

./yukarin-tools/count_checker.js -b dat/voice_src/voice_44100/yukari_pair/own -d dat/voice_src/voice_44100/yukari_pair/targetZ.5.3 フォーマットチェック

自作ツールで、wav ファイルのフォーマットをチェックします。

-sでチェックするサンプリングレートを指定します./yukarin-tools/format_checker.js dat/voice_src/voice_44100/yukari_pair/own -s 44100 ./yukarin-tools/format_checker.js dat/voice_src/voice_44100/yukari_pair/target -s 44100 ./yukarin-tools/format_checker.js dat/voice_src/voice_44100/yukari_single -s 44100問題がなければ下記のようなメッセージが表示されます。

./yukarin-tools/format_checker.js dat/voice_src/voice_44100/yukari_single -s 44100 debug : {"src":"dat/voice_src/voice_44100/yukari_pair/own","sampling":44100} all files format : > channels : 1 > bits per sample : 16 > encoding : Signed Integer PCM > sampling : 44100 result : OKZ.5.4 リサンプリング

収録音声を Yukarinライブラリのデフォルトフォーマット 24000Hz /16 bit に変換します。

-bサンプリングする元データディレクトリ-dサンプリングしたデータを入れるディレクトリ(念の為、上書きできないようにしています)-sでチェックするサンプリングレートを指定します./yukarin-tools/resampling.js -b dat/voice_src/voice_44100/yukari_pair/own -d dat/voice_src/voice_24000/yukari_pair/own -s 24000 ./yukarin-tools/resampling.js -b dat/voice_src/voice_44100/yukari_pair/target -d dat/voice_src/voice_24000/yukari_pair/target -s 24000 ./yukarin-tools/resampling.js -b dat/voice_src/voice_44100/yukari_single -d dat/voice_src/voice_24000/yukari_single -s 24000自声(own)のリサンプリングで下記のような Warnが出るかもしれません。

これは、『ボリュームMAX超えているのがあるけどええんか?』的な、注意です。

アラートで、5 samplesの部分が100 samplesとか大きな数字になっていなければ、大丈夫です。sox WARN rate: rate clipped 5 samples; decrease volume? sox WARN dither: dither clipped 5 samples; decrease volume?Z.5.5 リサンプリングのチェック

しつこいですが、リサンプリング結果をチェックします。