- 投稿日:2021-03-01T23:57:05+09:00

【Scanpy, scRNA-seq】ScanpyのUMAPに再現性を持たせる

起きていた問題

Scanpyで描いたUMAPに再現性がない。

予想としてはPCAの部分で相違が生まれていそう。環境

こちらのDockerイメージをスパコンのSingularityコンテナとして利用。

バージョン情報:scanpy==1.7.0 anndata==0.7.5 umap==0.5.1 numpy==1.19.2 scipy==1.5.2 pandas==1.1.3 scikit-learn==0.23.2 statsmodels==0.12.0 python-igraph==0.9.0 louvain==0.7.0 leidenalg==0.8.3,解決方法

#1187で議論されているように、環境変数

OMP_NUM_THREADSを設定し、BLAS librariesが使用するCPU数を制限することで再現性が確保された。import os os.environ['OMP_NUM_THREADS'] = '1' import numpy as np import pandas as pd import scanpy as sc 〜以下省略〜疑問・補足

ローカルのDockerコンテナおよびJupyterLab上では、同様にしても再現性を確保できなかった。

なぜ?また今回は上記の環境変数

OMP_NUM_THREADSのみの指定で再現性が確保されたが、

#313で取り上げられている通り、ハッシュランダム化を無効化する、os.environ['PYTHONHASHSEED'] = '0'についても指定しておいたほうが良さそう。

- 投稿日:2021-03-01T23:47:14+09:00

playwright-pytestで失敗時の動画を撮っておく

まえおき

playwright-pytest を使ってE2Eテストを始める方法については、以前に以下の記事で紹介した。

ここでは、失敗時の画面キャプチャを撮る方法までは書いたが、実際に自動試験スクリプトを書いていると「どうしてそうなった?!」と思うことが稀によくある。(しかも、そんなテストに限って、じっと見張っていると何回やってもpassしたりするw)

不毛すぎるので、見張らなくてもいいようにエビデンス動画を残しておきたいと思うのがエンジニアである。

playwright-pythonで動画を撮る方法

playwright-python には、自動操作中の動画を記録する機能がある。

以下の記事でも言及されているように、

browser.new_context()もしくはbrowser.new_page()の引数にrecord_video_dir: ./videos/のように指定すればいい。

ただ、これはplaywright-pythonの話であり、そのままplaywright-pytestでは運用できない。なぜかというと

- 成功時の動画はべつに要らない

- 失敗時の動画は「ディレクトリに置いてあるのを見ろ」だと面倒なので、Allureレポートに添付したい

(特に2つめの理由が大きい)

playwright-pytest でAllureレポートに失敗時の動画を添付する方法

本題。

動画を撮る

テスト開始時に、そのテストが開始するか失敗するかはわからないので、動画の記録自体は無条件に行う。

playwright-pytestのソースを見ると、new_contextに渡す引数は

browser_context_argsでカスタマイズできるようになっているので、適当にconftest.pyあたりに以下を追加する。@pytest.fixture(scope="session") def browser_context_args(browser_context_args, tmpdir_factory: pytest.TempdirFactory): return { **browser_context_args, "record_video_dir": tmpdir_factory.mktemp('videos') }

record_video_dirは一時ディレクトリを作って、テスト終了後には消える場所にしているのがポイント。テスト失敗時のレポートに動画を添付する

def pytest_runtest_makereport(item, call) -> None: if call.when == "call": if call.excinfo is not None and "page" in item.funcargs: page: Page = item.funcargs["page"] # ref: https://stackoverflow.com/q/29929244 allure.attach( page.screenshot(type='png'), name=f"{slugify(item.nodeid)}.png", attachment_type=allure.attachment_type.PNG ) video_path = page.video.path() page.context.close() # ensure video saved allure.attach( open(video_path, 'rb').read(), name=f"{slugify(item.nodeid)}.webm", attachment_type=allure.attachment_type.WEBM )スクリーンショットを撮ったあとの video_path = ... からの処理が動画の記録部分。

Playwrightの動画記録は、BrowserContext#close したタイミングで書き込みが完了されるので、明示的にcloseを読んで動画ファイルを確定させてからattachしているのがポイント。

もし明示的にcloseを呼ばないと、0秒の動画が貼り付けられたり、手順の途中で切れた動画が添付されたりするので注意。Allureレポートでは、以下のように、事象が起きたときの様子を見ることができる。

まとめ

Flakyテストを眺めるのがしんどくなってきたので、自動テストの動画を撮る方法を調べてまとめました。

これで自動テストを放置して、コンビニにコーヒーを買いに行ける!(笑)

- 投稿日:2021-03-01T22:46:41+09:00

機械学習アルゴリズムメモ 正則化線形回帰編

正則化とは

特徴量の多いデータに対して過剰適合する線形回帰モデルの重みパラメータに対して制約を加えることで、過剰適合するのを防ぐ。リッジ回帰、ラッソ回帰、エラスティックネット回帰の3つが代表としてあげられる。

【ラッソ回帰】

線形回帰と同様に、予測はデータの特徴量の線形和としてあらわされる。

\hat{y} = \sum_{i=1}^{p} w_ix + bしかしながら、損失関数は通常の線形回帰に重みwに対する制約が与えられる。ラッソ回帰の場合はL1ノルムである。

E(w, b) = \frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y_i}) ^ 2 + \alpha \sum_{i=1}^{p} |w_i|【リッジ回帰】

\hat{y} = \sum_{i=1}^{p} w_ix + bリッジ回帰の場合はL2ノルムである。

E(w, b) = \frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y_i}) ^ 2 + \frac{1}{2} \alpha \sum_{i=1}^{p} |w_i|^2【エラスティックネット回帰】

\hat{y} = \sum_{i=1}^{p} w_ix + bエラスティックネット回帰の場合ラッソ回帰とリッジ回帰を組み合わせたような損失関数を定義する。

E(w, b) = \frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y_i}) ^ 2 + r\alpha \sum_{i=1}^{p} |w_i| + \frac{1 - r}{2} \alpha \sum_{i=1}^{p} |w_i|^2scikit-learnでの使い方

【ラッソ回帰】

from sklearn.linear_model import Lasso lasso = Lasso() lasso.fit(X_train, y_train) lasso.score(X_test, y_test)【リッジ回帰】

from sklearn.linear_model import Ridge ridge = Ridge() ridge.fit(X_train, y_train) ridge.score(X_test, y_test)【エラスティックネット回帰】

from sklearn.linear_model import ElasticNet elastic = ElasticNet() elastic.fit(X_train, y_train) elastic.score(X_test, y_test)パラメータ

scikit-learnでのパラメータ名 概要 初期値 特性 alpha 正則化係数 1.0 大きくすると強く正則化する。 l1_ratio L1正則化率 0.5 大きくするとラッソ回帰に、小さくするとリッジ回帰に近づく。 メリット

正則化を行うので過剰適合しにくくなり、汎用モデルとなる。

デメリット

正則化に失敗するとそもそも適合しなくなり、単純な線形モデルよりも精度が悪くなる場合がある。

ラッソ回帰では小さな重みが0になってしまうことが多い。

- 投稿日:2021-03-01T22:23:32+09:00

Fizz Buzz を色んな言語でプログラミングしてみよう!

はじめに

この記事では、FizzBuzzゲームのプログラミングコードを紹介する。とりあえず、Python、Fortran、C++で書いたコードを2つずつ見てみよう。

目次

1.そもそもFizzBuzzゲームとは?

2.Python

3.Fortran

4.C++そもそも FizzBuzzゲームとは?

Python

for文for i in range(1, 101): if i % 15 == 0: print('Fizz Buzz') elif i % 3 == 0: print('Fizz') elif i % 5 == 0: print('Buzz') else: print(i)while文i = 1 while i < 101: if i % 15 == 0: print('Fizz Buzz') elif i % 3 == 0: print('Fizz') elif i % 5 == 0: print('Buzz') else: print(i) i += 1Fortran

条件分岐とループによるプログラム! fizzbuzz.f90 ! G95でコンパイル ! Fortran90/95では、複数行コメントは非サポート program fizzbuzz implicit none integer i do i = 1, 100 ! iが3の倍数かつ5の倍数 if (mod(i, 3) == 0 .and. mod(i, 5) == 0) then print *, "FizzBuzz" ! iが3の倍数(かつ、5の倍数でない) else if (mod(i, 3) == 0) then print *, "Fizz" ! iが5の倍数(かつ、3の倍数でない) else if (mod(i, 5) == 0) then print *, "Buzz" ! iが3の倍数でも5の倍数でもない else print *, i end if end do end program fizzbuzzサブルーチンの再帰呼び出しによるプログラム! fizzbuzz_rc.f90 ! G95でコンパイル ! Fortran90/95では、複数行コメントは非サポート program fizzbuzz_rc implicit none call fizzbuzz(100) contains recursive subroutine fizzbuzz(n) integer n if (n > 1) then call fizzbuzz(n-1) end if ! nが3の倍数かつ5の倍数 if (mod(n, 3) == 0 .and. mod(n, 5) == 0) then print *, "Fizz,Buzz" ! nが3の倍数(かつ、5の倍数でない) else if (mod(n, 3) == 0) then print *, "Fizz" ! nが5の倍数(かつ、3の倍数でない) else if (mod(n, 5) == 0) then print *, "Buzz" ! nが3の倍数でも5の倍数でもない else print *, n end if end subroutine end program fizzbuzz_rcC++

条件分岐とループによるプログラム/* fizzbuzz.cpp */ #include <iostream> using namespace std; int main() { for (int i = 1; i <= 100; i++) { if (i % 3 == 0 && i % 5 == 0) // iが3の倍数かつ5の倍数 cout << "Fizz,Buzz" << endl; else if (i % 3 == 0) // iが3の倍数(かつ、5の倍数でない) cout << "Fizz" << endl; else if (i % 5 == 0) // iが5の倍数(かつ、3の倍数でない) cout << "Buzz" << endl; else // iが3の倍数でも5の倍数でもない cout << i << endl; } return 0; }関数の再帰呼び出しによるプログラム/* fizzbuzz_rc.cpp */ #include <iostream> using namespace std; void fizzbuzz(int n) { if (n > 1) fizzbuzz(n-1); if (n % 3 == 0 && n % 5 == 0) // nが3の倍数かつ5の倍数 cout << "Fizz,Buzz" << endl; else if (n % 3 == 0) // nが3の倍数(かつ、5の倍数でない) cout << "Fizz" << endl; else if (n % 5 == 0) // nが5の倍数(かつ、3の倍数でない) cout << "Buzz" << endl; else // nが3の倍数でも5の倍数でもない cout << n << endl; } int main() { fizzbuzz(100); return 0; }

- 投稿日:2021-03-01T22:23:32+09:00

多言語で Fizz Buzz !

はじめに

この記事では、FizzBuzzゲームのプログラミングコードを紹介する。とりあえず、Python、Fortran、C++で書いたコードを2つずつ見てみよう。

目次

1.そもそもFizzBuzzゲームとは?

2.Python

3.Fortran

4.C++そもそも FizzBuzzゲームとは?

Python

for文for i in range(1, 101): if i % 15 == 0: print('Fizz Buzz') elif i % 3 == 0: print('Fizz') elif i % 5 == 0: print('Buzz') else: print(i)while文i = 1 while i < 101: if i % 15 == 0: print('Fizz Buzz') elif i % 3 == 0: print('Fizz') elif i % 5 == 0: print('Buzz') else: print(i) i += 1Fortran

条件分岐とループによるプログラム! fizzbuzz.f90 ! G95でコンパイル ! Fortran90/95では、複数行コメントは非サポート program fizzbuzz implicit none integer i do i = 1, 100 ! iが3の倍数かつ5の倍数 if (mod(i, 3) == 0 .and. mod(i, 5) == 0) then print *, "FizzBuzz" ! iが3の倍数(かつ、5の倍数でない) else if (mod(i, 3) == 0) then print *, "Fizz" ! iが5の倍数(かつ、3の倍数でない) else if (mod(i, 5) == 0) then print *, "Buzz" ! iが3の倍数でも5の倍数でもない else print *, i end if end do end program fizzbuzzサブルーチンの再帰呼び出しによるプログラム! fizzbuzz_rc.f90 ! G95でコンパイル ! Fortran90/95では、複数行コメントは非サポート program fizzbuzz_rc implicit none call fizzbuzz(100) contains recursive subroutine fizzbuzz(n) integer n if (n > 1) then call fizzbuzz(n-1) end if ! nが3の倍数かつ5の倍数 if (mod(n, 3) == 0 .and. mod(n, 5) == 0) then print *, "Fizz,Buzz" ! nが3の倍数(かつ、5の倍数でない) else if (mod(n, 3) == 0) then print *, "Fizz" ! nが5の倍数(かつ、3の倍数でない) else if (mod(n, 5) == 0) then print *, "Buzz" ! nが3の倍数でも5の倍数でもない else print *, n end if end subroutine end program fizzbuzz_rcC++

条件分岐とループによるプログラム/* fizzbuzz.cpp */ #include <iostream> using namespace std; int main() { for (int i = 1; i <= 100; i++) { if (i % 3 == 0 && i % 5 == 0) // iが3の倍数かつ5の倍数 cout << "Fizz,Buzz" << endl; else if (i % 3 == 0) // iが3の倍数(かつ、5の倍数でない) cout << "Fizz" << endl; else if (i % 5 == 0) // iが5の倍数(かつ、3の倍数でない) cout << "Buzz" << endl; else // iが3の倍数でも5の倍数でもない cout << i << endl; } return 0; }関数の再帰呼び出しによるプログラム/* fizzbuzz_rc.cpp */ #include <iostream> using namespace std; void fizzbuzz(int n) { if (n > 1) fizzbuzz(n-1); if (n % 3 == 0 && n % 5 == 0) // nが3の倍数かつ5の倍数 cout << "Fizz,Buzz" << endl; else if (n % 3 == 0) // nが3の倍数(かつ、5の倍数でない) cout << "Fizz" << endl; else if (n % 5 == 0) // nが5の倍数(かつ、3の倍数でない) cout << "Buzz" << endl; else // nが3の倍数でも5の倍数でもない cout << n << endl; } int main() { fizzbuzz(100); return 0; }

- 投稿日:2021-03-01T22:14:06+09:00

【optimizer入門】性質を変えて遊んでみる♬

前回は、optimizerを可視化して、その性質の一端を見た。

今回は、さらに深堀して性質からどのように利用できるかを考える。

前回の追記にするか迷ったが、角度を変えて記述することにより、より理解が深まると考えて、続編というよりは別偏とすることにしました。

とりあえず、内容と直接関係ないが、以下を参考として挙げておく

【参考】

①Optimization Algorithms in Deep Learning-AdaGrad, RMSProp, Gradient Descent with Momentum & Adam Optimizer demystified;AdaGrad、RMSProp、勢いのある最急降下法とAdamOptimizerの謎を解き明かすやったこと

・VGD、momentum、そしてgrad規格化という3つの性質

・momentumの変数beta1の役割

・grad規格化の変数beta2の役割

・adamでRMSpropとmomentumを再現する

・Cifar10のカテゴライズでoptimを試してみる・VGD、momentum、そしてgrad規格化という3つの性質

数式で見ると以下のとおり

以下が勾配降下法VGDで単純に等高線に垂直に移動する。これが極小値を求めるための基本原理。VDG.pyx = x - alpha * grad(x)以下がVGDに運動量(履歴)概念を導入したVDGで、収束が早まると期待できる。

VDGwithmomentum.pym = beta*v + (1-beta)*grad(x) x = x - alpha * mc以下は、VDGとは異なり、傾きの異方性を排除するため(傾きの大きい方ばかりに行かないよう)にgradで規格化するRMSpropの手法。

RMSprop.pyv = beta2*v + (1-beta2)*grad(x)**2 x = x - alpha * grad(x) / (eps + np.sqrt(v))以下のコードでbeta1=0.2及びbeta2=0.5の場合の初期値の違いによる収束の様子を見ます。

p_list = {-2,-1,-0.5,1} for p in p_list: x0 = np.array([p,-1]) x = np.linspace(-2.2, 1.2, 100) y = np.linspace(-1.2, 1.2, 100) X, Y = np.meshgrid(x, y) levels = [0.1,0.2,0.5,1,2,5,10,20,50,100] Z = x**2 + 100*Y**2 beta1 =0.2 beta2 =0.5 al_list = {0.0075} for al in al_list: alpha = al xs = gd2(x0, grad2, alpha, max_iter=100) xsm = gd2_momentum(x0, grad2, alpha, beta=beta1, max_iter=100) xsg = gd2_rmsprop(x0, grad2, alpha, beta2=beta2, max_iter=100) c = plt.contour(X, Y, Z, levels) plt.plot(xs[:, 0], xs[:, 1], 'o-', c='red', label ='VGD') plt.plot(xsm[:, 0], xsm[:, 1], 'o-', c='blue', label = 'momentum_beta={}'.format(beta1)) plt.plot(xsg[:, 0], xsg[:, 1], 'o-', c='pink', label = 'RMSprop_beta={}'.format(beta2)) plt.title('gradient descent_Ir ={}_'.format(alpha)) plt.legend() plt.savefig('fig_y=x^2+100y^2_Ir{}withVGD_mbeta1{}_gbeta2{}_{}.png'.format(alpha,beta1,beta2,p)) plt.pause(1) plt.clf()結果は以下のとおりです。

特徴は、一目瞭然ですが、

①momentumの効果は、振動の安定化に寄与しています。しかしより原点に近いということはありません。

②gradでの規格化;RMSpropは、いきなり45度の方向へ進んでいます。beta2=0.5だとX=0の切片まで(1,1)方向など等方的な方向へ直線的に移動しているのが分かります。

③VGDが最も原点(これが今の極小値)に一番近づいています

学習率を大きくする

VGDは発散しやすく、次にmomentumを導入したものという順に発散してしまいます。

最後に残るのが、RMSpropで以下のように大きな学習率でも収束して原点まで到達してくれました。しかし、よく見るとIr=0.05の時は原点近傍で振動しているのが分かります。

・grad規格化の変数beta2の役割

adamを見る前に、RMSpropのbeta2の役割を見てみましょう。

結果は以下のようになりました。

①beta2の効果は0.9, 0.99 と変えることにより、その場の傾きの寄与が小さくなって、それまでの傾きの履歴に依存して向きが段々原点の方向へ回り込むようになりました

②収束性能が上がって、beta2=0.99, Ir=0.05では数えられる程度のポイントで急速に解に近づいて収束しているのが分かります

③上記の学習率が大きいときに発生していた原点近傍も消えました。

・adamでRMSpropとmomentumを再現する

adamのコードは以下のとおり、RMSpropとmomentumを両者取り入れたものとなっています。

m = beta1*m + (1-beta1)*grad(x) v = beta2*v + (1-beta2)*grad(x)**2 x = x - alpha * m / (eps + np.sqrt(v))上記のコードでbeta1=0と置くと上のRMSpropと同じコードになります。

また、beta2=1, v =定数 が、momentumのコードになります。ということで、adamの最適なパラメータを見てみます。

RMSpropと同じ結果から調査を始めます。AdamとRMSpropを比較する

まず、beta1=0-0.9まで変化したときのAdamの振る舞いをRMSpropと比較します。

lrを0.005から0.01に増加すると、RMSpropはより急速に原点に収束しているのが分かります。そして、Adamはbeta1=0ではRMSpropと同じ振る舞いですが、beta1が大きくなると、蛇行して原点に接近するのが分かります。

この時点ではAdamの優位性(beta1の効果)が良い方向に寄与しているかどうか不明です。

さらに、学習率を大きくする。

lr=0.05-0.1に増加して同じことをやってみます。

RMSpropはかなり遠い位置に飛ばされてしまいますが、二度目に戻ってきて収束しています。一方、Adamはそれほど飛ばされることもなく、ゆっくりですが、原点近傍を振動しつつ収束します。一応、Adamのbeta1の効果があると言えると思います。

そして、さらに学習率の大きなところを見てみます。

RMSpropはさらに遠方に飛ばされますがそれでも戻ってきているようです。そしてAdamは学習率0.2では一定の割合で近いところで収束していますが、学習率が0.5で、特に最後のものは振動して収束していないように見えます。

ここまでの解析は以下のコード、つまり自前のgradient descentのコードでやっています。

自前のgradient descentのコード

def gd2_rmsprop(x, grad, alpha, beta2=0.9, eps=1e-8, max_iter=10): xs = np.zeros((1 + max_iter, x.shape[0])) xs[0, :] = x v = 0 for i in range(max_iter): v = beta2*v + (1-beta2)*grad(x)**2 x = x - alpha * grad(x) / (eps + np.sqrt(v)) xs[i+1, :] = x return xs def gd2_adam(x, grad, alpha, beta1=0.9, beta2=0.999, eps=1e-8, max_iter=10): xs = np.zeros((1 + max_iter, x.shape[0])) xs[0, :] = x m = 0 v = 0 for i in range(max_iter): m = beta1*m + (1-beta1)*grad(x) v = beta2*v + (1-beta2)*grad(x)**2 #mc = m/(1+beta1**(i+1)) #vc = v/(1+beta2**(i+1)) x = x - alpha * m / (eps + np.sqrt(v)) xs[i+1, :] = x return xs p = -2 #0.5 beta2_list = {0.999} beta1 = 0.1 #0.2 #0.7 #0 #0.5 #0.9 fig = plt.figure(figsize=(15, 10)) ax1 = fig.add_subplot(1, 2, 1) ax2 = fig.add_subplot(1, 2, 2) for beta2 in beta2_list: al_list = {0.5} x0 = np.array([p,-1]) x = np.linspace(-2.2, 1.2, 100) y = np.linspace(-1.2, 1.2, 100) X, Y = np.meshgrid(x, y) levels = [0.1,0.2,0.5,1,2,5,10,20,50,100] Z = x**2 + 100*Y**2 for al in al_list: alpha = al #0.01 xsg = gd2_adam(x0, grad2, alpha, beta1 = beta1, beta2=beta2, max_iter=100) xsr = gd2_rmsprop(x0, grad2, alpha, beta2=beta2, max_iter=100) c1 = ax1.contour(X, Y, Z, levels) ax2.plot(xsg[:10, 0], xsg[:10, 1], 'o-', c='red', label = 'Adam_beta1={}beta2={}'.format(beta1,beta2)) ax2.plot(xsg[10:, 0], xsg[10:, 1], 'o-', c='blue', label = 'Adam_beta1={}beta2={}'.format(beta1,beta2)) ax2.set_title('gradient descent_Adam_Ir ={}'.format(alpha)) c2 = ax2.contour(X, Y, Z, levels) ax1.plot(xsr[:10, 0], xsr[:10, 1], 'o-', c='red', label = 'RMSprop_beta2={}'.format(beta2)) ax1.plot(xsr[10:, 0], xsr[10:, 1], 'o-', c='blue', label = 'RMSprop_beta2={}'.format(beta2)) ax1.set_title('gradient descent_RMSprop_Ir ={}'.format(alpha)) ax1.legend() ax2.legend() plt.savefig('fig_y=x^2+100y^2_Ir{}withadam_mbeta1_{}gbeta2{}_{}.png'.format(alpha,beta1,beta2,p)) plt.pause(1) plt.clf()pytorch.optimのAdamとRMSpropを比較する

上記の結果ははっきり言って、意外でした。これだとRMSpropが優秀な結果だと解釈できます。

ということで、自前コードが、実際に利用しているpytorchのoptim.adamとoptim.rmspropと同じようなふるまいをするかどうかを調べてみました。

まず、自前コード側は以下のとおりです。beta1=0のとき、RMSpropとAdamの振る舞いはRMSpropのそれと同じになっています。

ところが、pytorchの関数の振る舞いは以下の通りです。beta1=0でも両者で異なる振る舞いをしています。しかし、明らかにRMSpropの方が収束が速いと評価できます。青い点が原点に収束しています。

※しかも、赤い点の範囲でより原点に近づいています

そして、学習率0.02-1の大きな範囲を比較してみます。こちらもRMSpropの成績がいいように見えます。

・Cifar10のカテゴライズでoptimを試してみる

どうも上記の結果だとRMSpropの性能がいいように感じるが、普段の学習ではAdamの方がいいような気がしており、そのギャップを再度確認するために、いろいろなoptimizerで同じ条件で試してみる。ここでは、一応pytorch推奨のパラメータを利用するnetworkは自前のVGG16で10epochのみの学習で精度をみた。

結果は、それぞれ以下のとおりとなり、残念ながら差はあまり出なかったと言える。optimizer = torch.optim.Adam(self.parameters(), lr=0.001, betas=(0.9, 0.999), eps=1e-08, weight_decay=0, amsgrad=False)

Epoch 0: 100%|██████████████████| 1563/1563 [01:07<00:00, 23.23it/s, loss=1.24, v_num=11, val_loss=1.43, val_acc=0.501] Epoch 1: 100%|████████████████| 1563/1563 [01:07<00:00, 23.03it/s, loss=0.903, v_num=11, val_loss=0.994, val_acc=0.653] Epoch 2: 100%|█████████████████| 1563/1563 [01:07<00:00, 23.04it/s, loss=0.74, v_num=11, val_loss=0.842, val_acc=0.709] Epoch 3: 100%|████████████████| 1563/1563 [01:08<00:00, 22.89it/s, loss=0.662, v_num=11, val_loss=0.797, val_acc=0.731] Epoch 4: 100%|████████████████| 1563/1563 [01:07<00:00, 23.31it/s, loss=0.554, v_num=11, val_loss=0.817, val_acc=0.735] Epoch 5: 100%|████████████████| 1563/1563 [01:06<00:00, 23.35it/s, loss=0.469, v_num=11, val_loss=0.834, val_acc=0.742] Epoch 6: 100%|████████████████| 1563/1563 [01:08<00:00, 22.91it/s, loss=0.405, v_num=11, val_loss=0.725, val_acc=0.786] Epoch 7: 100%|████████████████| 1563/1563 [01:06<00:00, 23.38it/s, loss=0.291, v_num=11, val_loss=0.727, val_acc=0.794] Epoch 8: 100%|████████████████| 1563/1563 [01:07<00:00, 23.26it/s, loss=0.244, v_num=11, val_loss=0.831, val_acc=0.779] Epoch 9: 100%|█████████████████| 1563/1563 [01:07<00:00, 23.01it/s, loss=0.169, v_num=11, val_loss=0.918, val_acc=0.78] Epoch 9: 100%|█████████████████| 1563/1563 [01:07<00:00, 23.01it/s, loss=0.169, v_num=11, val_loss=0.918, val_acc=0.78] Files already downloaded and verified Files already downloaded and verified Testing: 100%|███████████████████████████████████████████████████████████████████████| 313/313 [00:05<00:00, 53.45it/s] -------------------------------------------------------------------------------- DATALOADER:0 TEST RESULTS {'val_acc': tensor(0.7801, device='cuda:0'), 'val_loss': tensor(0.7414, device='cuda:0')} --------------------------------------------------------------------------------optimizer = torch.optim.RMSprop(self.parameters(), lr=0.01, alpha=0.99, eps=1e-08, weight_decay=0, momentum=0, centered=False)

Epoch 0: 100%|██████████████████| 1563/1563 [01:03<00:00, 24.68it/s, loss=1.72, v_num=12, val_loss=1.67, val_acc=0.358] Epoch 1: 100%|██████████████████| 1563/1563 [01:03<00:00, 24.50it/s, loss=1.26, v_num=12, val_loss=1.54, val_acc=0.439] Epoch 2: 100%|█████████████████| 1563/1563 [01:03<00:00, 24.71it/s, loss=0.946, v_num=12, val_loss=1.42, val_acc=0.534] Epoch 3: 100%|███████████████████| 1563/1563 [01:03<00:00, 24.66it/s, loss=0.8, v_num=12, val_loss=1.33, val_acc=0.589] Epoch 4: 100%|██████████████████| 1563/1563 [01:03<00:00, 24.66it/s, loss=0.669, v_num=12, val_loss=1.13, val_acc=0.66] Epoch 5: 100%|████████████████| 1563/1563 [01:03<00:00, 24.51it/s, loss=0.554, v_num=12, val_loss=0.917, val_acc=0.714] Epoch 6: 100%|████████████████| 1563/1563 [01:04<00:00, 24.25it/s, loss=0.432, v_num=12, val_loss=0.807, val_acc=0.755] Epoch 7: 100%|████████████████| 1563/1563 [01:04<00:00, 24.22it/s, loss=0.383, v_num=12, val_loss=0.727, val_acc=0.776] Epoch 8: 100%|█████████████████| 1563/1563 [01:03<00:00, 24.64it/s, loss=0.33, v_num=12, val_loss=0.771, val_acc=0.783] Epoch 9: 100%|████████████████| 1563/1563 [01:03<00:00, 24.62it/s, loss=0.272, v_num=12, val_loss=0.781, val_acc=0.792] Epoch 9: 100%|████████████████| 1563/1563 [01:03<00:00, 24.62it/s, loss=0.272, v_num=12, val_loss=0.781, val_acc=0.792] Files already downloaded and verified Files already downloaded and verified Testing: 100%|███████████████████████████████████████████████████████████████████████| 313/313 [00:05<00:00, 53.76it/s] -------------------------------------------------------------------------------- DATALOADER:0 TEST RESULTS {'val_acc': tensor(0.7639, device='cuda:0'), 'val_loss': tensor(0.7649, device='cuda:0')} --------------------------------------------------------------------------------optimizer = torch.optim.SGD(self.parameters(), lr=0.1, momentum=0, dampening=0, weight_decay=0, nesterov=False)

Epoch 0: 100%|████████████████████| 1563/1563 [00:56<00:00, 27.48it/s, loss=1.7, v_num=9, val_loss=1.87, val_acc=0.345] Epoch 1: 100%|████████████████████| 1563/1563 [00:57<00:00, 27.21it/s, loss=1.23, v_num=9, val_loss=1.26, val_acc=0.54] Epoch 2: 100%|█████████████████| 1563/1563 [00:57<00:00, 27.18it/s, loss=0.856, v_num=9, val_loss=0.926, val_acc=0.685] Epoch 3: 100%|█████████████████| 1563/1563 [00:57<00:00, 27.13it/s, loss=0.664, v_num=9, val_loss=0.847, val_acc=0.717] Epoch 4: 100%|█████████████████| 1563/1563 [00:58<00:00, 26.70it/s, loss=0.559, v_num=9, val_loss=0.795, val_acc=0.736] Epoch 5: 100%|█████████████████| 1563/1563 [00:58<00:00, 26.69it/s, loss=0.454, v_num=9, val_loss=0.912, val_acc=0.718] Epoch 6: 100%|███████████████████| 1563/1563 [00:58<00:00, 26.57it/s, loss=0.4, v_num=9, val_loss=0.745, val_acc=0.774] Epoch 7: 100%|█████████████████| 1563/1563 [00:58<00:00, 26.76it/s, loss=0.315, v_num=9, val_loss=0.753, val_acc=0.783] Epoch 8: 100%|█████████████████| 1563/1563 [00:58<00:00, 26.54it/s, loss=0.245, v_num=9, val_loss=0.692, val_acc=0.801] Epoch 9: 100%|██████████████████| 1563/1563 [00:58<00:00, 26.72it/s, loss=0.22, v_num=9, val_loss=0.754, val_acc=0.794] Epoch 9: 100%|██████████████████| 1563/1563 [00:58<00:00, 26.72it/s, loss=0.22, v_num=9, val_loss=0.754, val_acc=0.794] Files already downloaded and verified Files already downloaded and verified Testing: 100%|███████████████████████████████████████████████████████████████████████| 313/313 [00:05<00:00, 53.47it/s] -------------------------------------------------------------------------------- DATALOADER:0 TEST RESULTS {'val_acc': tensor(0.8036, device='cuda:0'), 'val_loss': tensor(0.6908, device='cuda:0')} --------------------------------------------------------------------------------optimizer = torch.optim.AdamW(self.parameters(), lr=0.001, betas=(0.9, 0.999), eps=1e-08, weight_decay=0.01, amsgrad=False)

Epoch 0: 100%|███████████████████| 1563/1563 [01:08<00:00, 22.94it/s, loss=1.22, v_num=13, val_loss=1.3, val_acc=0.527] Epoch 1: 100%|█████████████████| 1563/1563 [01:08<00:00, 22.75it/s, loss=0.977, v_num=13, val_loss=1.06, val_acc=0.632] Epoch 2: 100%|████████████████| 1563/1563 [01:08<00:00, 22.73it/s, loss=0.841, v_num=13, val_loss=0.872, val_acc=0.705] Epoch 3: 100%|████████████████| 1563/1563 [01:08<00:00, 22.67it/s, loss=0.682, v_num=13, val_loss=0.769, val_acc=0.744] Epoch 4: 100%|████████████████| 1563/1563 [01:08<00:00, 22.67it/s, loss=0.563, v_num=13, val_loss=0.704, val_acc=0.766] Epoch 5: 100%|████████████████| 1563/1563 [01:08<00:00, 22.67it/s, loss=0.461, v_num=13, val_loss=0.678, val_acc=0.784] Epoch 6: 100%|████████████████| 1563/1563 [01:08<00:00, 22.74it/s, loss=0.394, v_num=13, val_loss=0.679, val_acc=0.789] Epoch 7: 100%|████████████████| 1563/1563 [01:08<00:00, 22.75it/s, loss=0.339, v_num=13, val_loss=0.711, val_acc=0.787] Epoch 8: 100%|████████████████| 1563/1563 [01:08<00:00, 22.86it/s, loss=0.186, v_num=13, val_loss=0.748, val_acc=0.795] Epoch 9: 100%|████████████████| 1563/1563 [01:08<00:00, 22.85it/s, loss=0.231, v_num=13, val_loss=0.749, val_acc=0.799] Epoch 9: 100%|████████████████| 1563/1563 [01:08<00:00, 22.85it/s, loss=0.231, v_num=13, val_loss=0.749, val_acc=0.799] Files already downloaded and verified Files already downloaded and verified Testing: 100%|███████████████████████████████████████████████████████████████████████| 313/313 [00:05<00:00, 53.72it/s] -------------------------------------------------------------------------------- DATALOADER:0 TEST RESULTS {'val_acc': tensor(0.7835, device='cuda:0'), 'val_loss': tensor(0.6767, device='cuda:0')} --------------------------------------------------------------------------------まとめ

・VGD, momentum, そしてgradでの規格化をそれぞれ比較し、性質を明らかにした

・RMSpropとAdamの比較を実施して、性質を明らかにした

・Cifar10のcategorizeに適用して、種々のoptimizerの性能を比較した・実際の学習への適用のような複雑なポテンシャル問題では、optimizerだけで、精度云々は一概に言えない。

- 投稿日:2021-03-01T20:26:10+09:00

PythonでFizzBuzz

Pythonの学習を始めた 備忘録

コード

for i in range(1,31): if i%3==0 and i%5==0: print("FizzBuzz") elif i%3==0: print("Fizz") elif i%5==0: print("Buzz") else: print(i)出力

1 2 Fizz 4 Buzz Fizz 7 8 Fizz Buzz 11 Fizz 13 14 FizzBuzz 16 17 Fizz 19 Buzz Fizz 22 23 Fizz Buzz 26 Fizz 28 29 FizzBuzz余談

Python超入門コース 合併版|Pythonの超基本的な部分をたった1時間で学べます【プログラミング初心者向け入門講座】

最初の一歩として上の動画を眺めた

FizzBuzzという問題の存在は知っていたので書いた

for文とif文の理解を試せてよかったところで、この出力結果は空間が余って嫌なので、横にカンマかなんかで区切って表示させたい あとでやる

- 投稿日:2021-03-01T19:24:55+09:00

Spotifyで聴いた曲を全部プレイリストに保存する

はじめに

Spotifyの履歴は50曲しか保存されないし、デスクトップアプリからしか確認できません。そこで再生した曲をプレイリストに自動追加してくれるスクリプトがあれば便利だと思い、このコードを書きました。プレイリストには1万曲まで追加できるようです。spotipyパッケージにAPIを叩いてもらうのが人気のようなのでこれを利用します。

(3月2日訂正)

以前はtokenを使った認証方法を記載していましたが、有効期限が1時間しかなく、1時間経つとエラーを吐いて止まってしまうようです。そこで公式のドキュメントで推奨されている

oauth2を使った認証方法に変更しました。今聴いている曲を取得

デベロッパーページ

https://developer.spotify.com/dashboard/applications

にアクセスして"CREATE AN APP"からAPPを作成し、クライアントIDとクライアントシークレットを入手します。

作ったAPPの"EDIT SETTINGS"から、"Redirect URIs"にhttps://example.com/callback/ を登録しておきます。予めクライアントIDなどを環境変数に設定しておきます(Mac、Linuxの場合は以下のコードを1行ずつコンソールで実行するか、適当な

〇〇.shファイルに保存してsource 〇〇.shを実行します。Windowsの場合はexportをSETに置き換えてコマンドプロンプトから1行ずつ実行するか、適当な〇〇.batファイルに保存して〇〇.batを実行します)。export SPOTIPY_CLIENT_ID='クライアントID' export SPOTIPY_CLIENT_SECRET='クライアントシークレット' export SPOTIPY_REDIRECT_URI='https://example.com/callback/'以下のコードの

scopeにはbotの権限を指定します。今回は現在再生している曲を読み出し、プレイリストに曲を追加したいのでuser-read-currently-playingとplaylist-modify-publicを指定します。非公開プレイリストに曲を追加していきたい場合はplaylist-modify-privateを指定します。import spotipy from spotipy.oauth2 import SpotifyOAuth scope = "user-read-currently-playing playlist-modify-public" sp = spotipy.Spotify(auth_manager=SpotifyOAuth(scope=scope)) current_playing = sp.current_user_playing_track() track_name = current_playing['item']['name'] track_id = current_playing["item"]["id"] artist_name = current_playing['item']['artists'][0]['name'] print(track_name + "/" + artist_name)このコードを走らせると、Spotifyの認証ページが開くので同意ボタンを押します。"Example Domain"と書かれたページにリダイレクトされるので、そのページのURLをコピーし、

Enter the URL you were redirected to:と表示しているコンソールにペーストします。今再生している曲名/アーティスト名が表示されれば成功です。

プレイリストに追加

曲を追加したいプレイリストのIDを調べます。プレイリストのシェア用URLは

https://open.spotify.com/playlist/37i9dQZF1DX7HOk71GPfSwのようになっていますが、最後の37i9dQZF1DX7HOk71GPfSwの部分がプレイリストのIDです。playlist_id = "プレイリストID" sp.playlist_add_items(playlist_id, [track_id], position=0)で

track_idの曲をプレイリストの先頭に追加することができます。完成

ループを回して30秒ごとに現在再生している曲を調べて、前回と異なる場合はプレイリストに追加します。

import spotipy from spotipy.oauth2 import SpotifyOAuth import time playlist_id = "プレイリストID" scope = "user-read-currently-playing playlist-modify-public" sp = spotipy.Spotify(auth_manager=SpotifyOAuth(scope=scope)) last_track_id = "" while True: current_playing = sp.current_user_playing_track() if current_playing is not None: track_name = current_playing['item']['name'] track_id = current_playing["item"]["id"] artist_name = current_playing['item']['artists'][0]['name'] if last_track_id != track_id: last_track_id = track_id print(track_name + "/" + artist_name) sp.playlist_add_items(playlist_id, [track_id], position=0) else: print("no song is playing...") time.sleep(30)参考にした記事

- 投稿日:2021-03-01T19:15:18+09:00

「うっせぇわ」でわかる再帰関数

def ussee(i): if i <= 0: return "わ" else: return f"うっせぇ{ussee(i-1)}" print("はぁ?") print(ussee(3)) # はぁ? # うっせぇうっせぇうっせぇわ関数

ussee(i)は、8行目のように呼び出すとその処理の中で5行目のように自身を呼び出します。このように処理の中で自身を呼び出すことを再帰呼び出しといい、再帰呼び出しを行う関数を再帰関数といいます。

再帰関数に終わりを設定しないと無限ループになるため大抵は自身を呼び出さないタイミング、すなわち再帰呼び出しの「終わり」を設定します。

ussee(i)だと以下の部分が「終わり」に該当します。if i <= 0: return "わ"そういった終わりの部分は基底部といいます。

この例では引数

iが呼び出しごとに1減算され、0以下になったときに再帰呼び出しが終わります。

ussee(i)に0を指定した場合、以下が出力されます。print("はぁ?") print(ussee(0)) # はぁ? # わわ (← かわいい)

ussee(100)を呼び出すとどうなるでしょう。print("はぁ?") print(ussee(100)) # はぁ? # うっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇうっせぇわでは

ussee(1000000000)ではどうでしょう。RecursionError: maximum recursion depth exceeded in comparison再帰呼び出しが多くなりすぎると、Pythonは途中でエラーを出して止めてくれます。

関数は呼び出しごとにメモリに呼び出し情報を蓄積するため、制限をかけないと大量のメモリを消費してしまいます。

以下のコードでPythonはどれくらいなら許してくれるのか確認することができます。

import sys print(sys.getrecursionlimit()) # 例: 10001000回までなら大丈夫だそうです。

以下のコードで制限を変更することもできます。

sys.setrecursionlimit(100000)制限を緩くしすぎた場合、それはメモリを大量に消費することを許すことになるため今度はメモリ自体の許容範囲を超えてしまうスタックオーバーフローという不具合が発生し、プログラムはクラッシュします。

import sys sys.setrecursionlimit(100000) def ussee(i): if i <= 0: return "わ" else: return f"うっせぇ{ussee(i-1)}" print("はぁ?") print(ussee(100000)) print("あ")この場合、最初の

はぁ?しか出力されません。異常エラーのため、クラッシュについては何も出力してくれません。こういったメモリを大量に消費してしまう問題を解決するため、「再帰関数はループしている」という性質をもとに

メモリに関数の呼び出し情報を蓄積しないようなプログラムに書き換える末尾呼び出し最適化という処置を施すプログラミング言語も存在します。

再帰関数は最初はわかりづらかったり、メモリ上の制限があったりなど注意することはありますが、実世界の問題解決において「再帰的な構造」という発想は物事をパターン化する上で非常に重要な考え方です。また、そういう文脈で最適化という処置が存在することも踏まえると、再帰関数をおさえておく価値は大きいように思います。

わが可愛いかったので つい出来心で書いてしまいました。お力になれたら幸いです。

- 投稿日:2021-03-01T18:50:23+09:00

Discord BotをPythonで!(discord.py)

最初に

この記事はpythonでのdiscord bot制作方法をまとめたものです。

ある程度のpython基礎知識が必要です。あとasyncioについての軽い知識があると便利です。

discord.pyを利用しbotを作成していきます。

botアカウントの作成はすでにできているという前提の元進めていきます。discord.pyのインストール

$ python3 -m pip install -U "discord.py[voice]"Botのひな形

import discord #TOKENには動かすbotのトークンを入れてください TOKEN='***************************' #最新のdiscord.pyを利用している人は一部の機能が制限?されているのでdiscord.Intents.allしてあげます。詳しくは調べればわかる intents=discord.Intents.all() #オブジェクト作成 client=discord.Client(intents=intents) #bot起動 client.run(TOKEN)各種イベント

起動イベント

@client.event async def on_ready(): print('Discord Bot Start!!!') #ここにbot起動時にさせたい処理を書くメッセージ送信を検知するイベント

@client.event async def on_message(message): #メッセージ送信者がbotだったときに処理を行わないようにする if message.author.bot: return #ここに処理 return応用

コマンド

discord.pyには便利なことにdiscord.ext.commandsというものがあります。ですが個人的にこれ使い勝手が悪いので自分でコマンドを実装することにします。

@client.event async def on_message(message): #メッセージ送信者がbotだったときに処理を行わないようにする if message.author.bot: return #メッセージを分割 args=message.content.split() #メインコマンドの判別 if args[0]=='!main': #サブコマンドの判別 if args[1]=='sub': await messgae.channel.send('!main subを実行しました') elif args[0]=='!test2': await message.channnel.send('!test2'を実行しました)コマンドはスペースで区切られているので、スペースで文字を分割しリストに入れてあげることで引数を参照しやすくなります。

さらにリスト化することで引数が足りない場合のエラー処理の実装が容易になります。最後に

この記事はまだ未完成です。

- 投稿日:2021-03-01T18:39:49+09:00

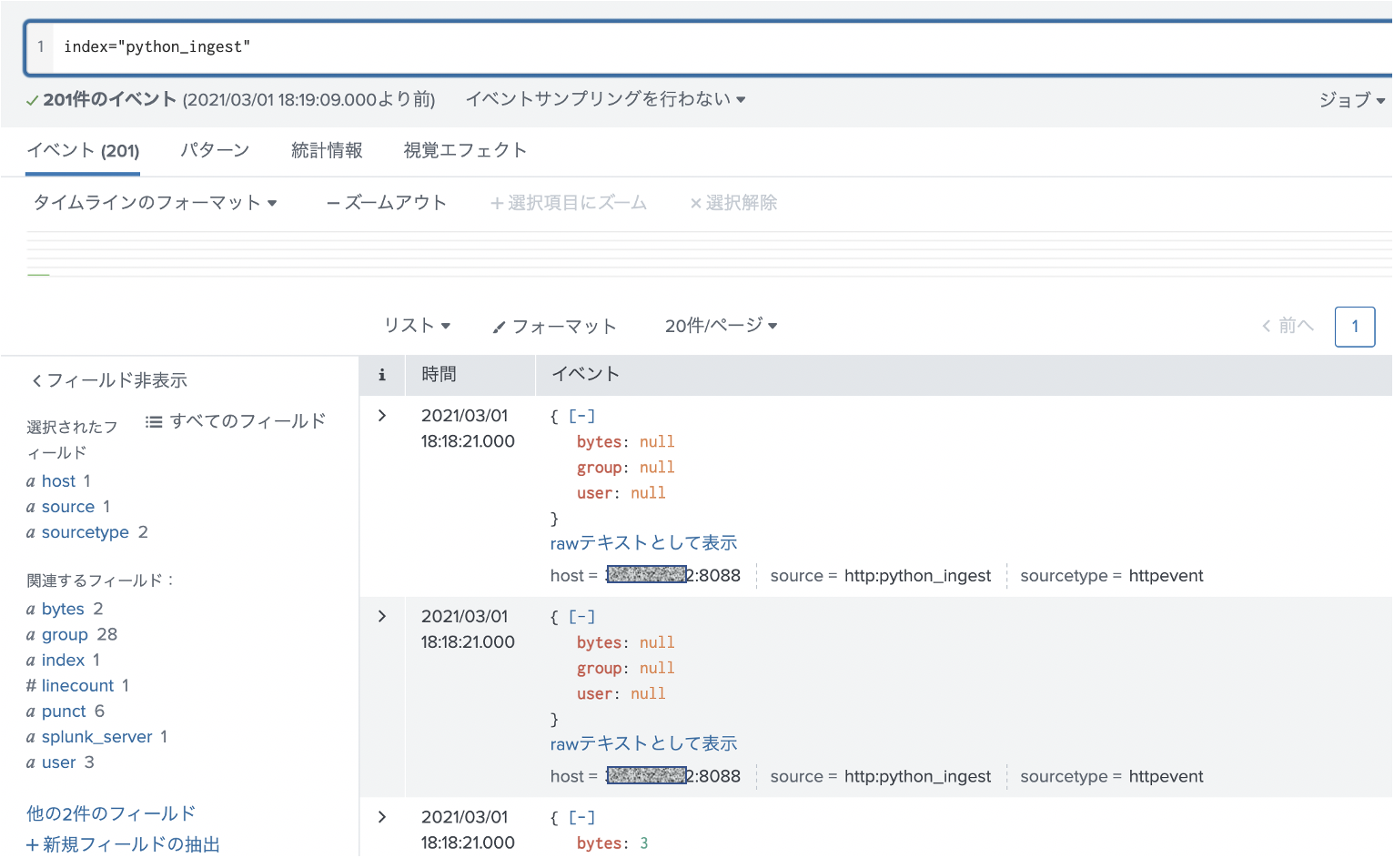

pythonでデータを Splunkに取り込む ( RestAPI + HECの組み合わせ)

はじめに

以前の記事で pythonで RestAPIを使ってサーチ結果を読み込む方法を書いたので、今度は逆にデータをSplunkに取り込む方法にチャレンジしてみます。

これができれば、データを取り込んで、加工して、その結果をSplunkに取り込むことが可能になります。(なんて便利な)

1. Splunk HECの設定

まずは、Splunk側の受け入れ体勢を整えておく必要があります。 Splunk側は HEC (HTTP Event Collector)という機能を設定して、RestAPI経由でデータを取り込むようにします。

HECの仕組みとしては、Global Portを設定して、データソースタイプ毎にTokenを発行することで、様々なログをRestAPIを使って取り込むことができます。またToken作成の際に sourcetypeやindexを指定できます。

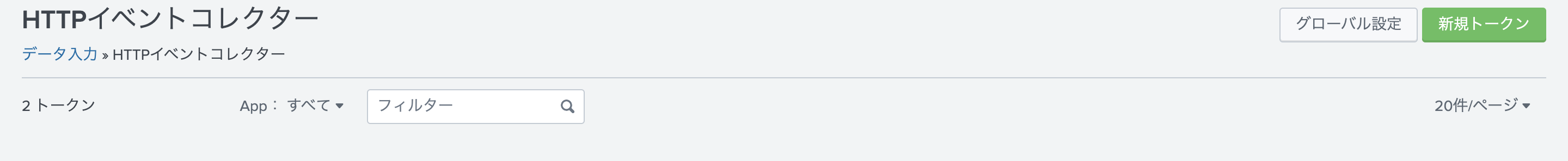

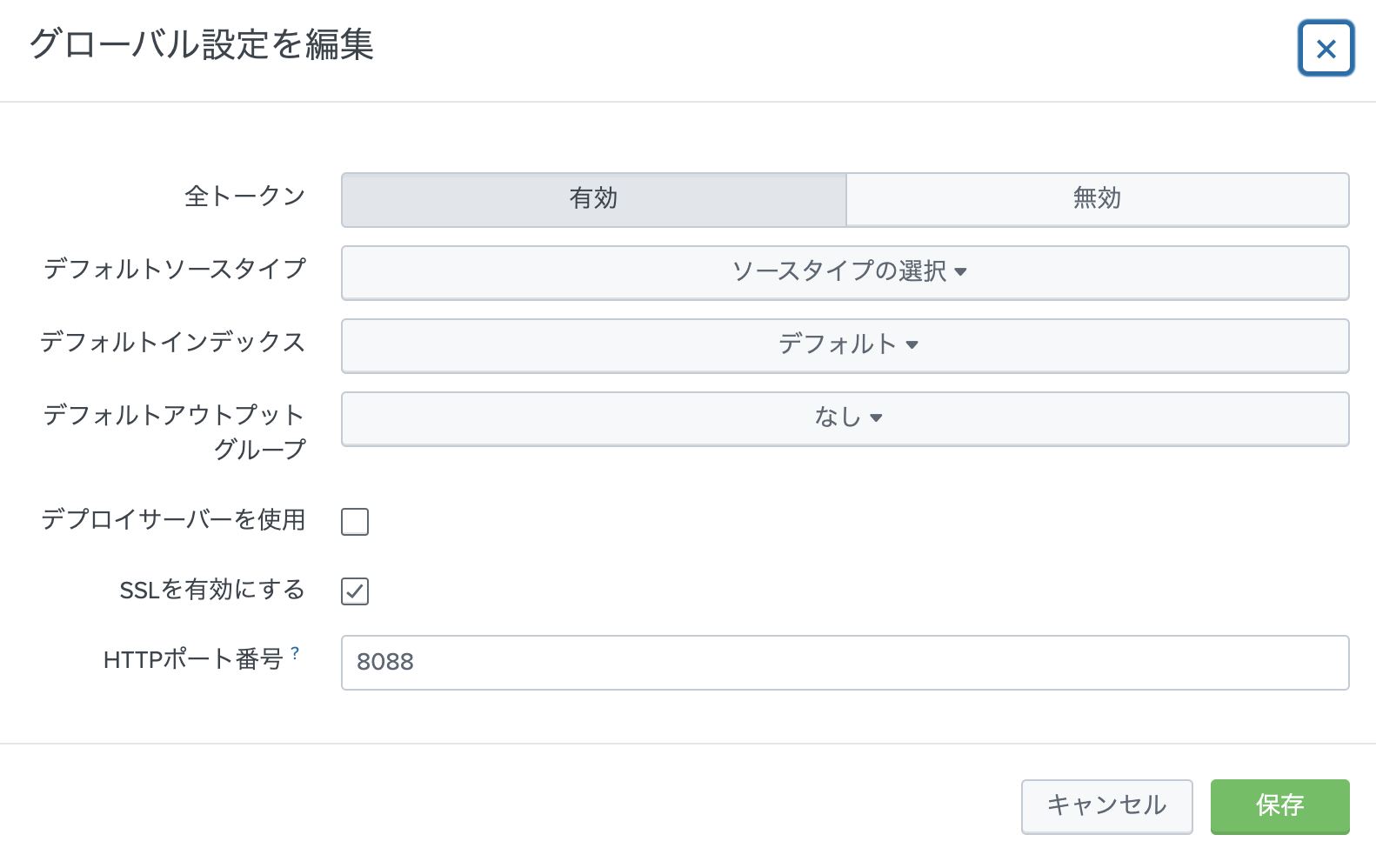

1-1. HECのGlobal設定

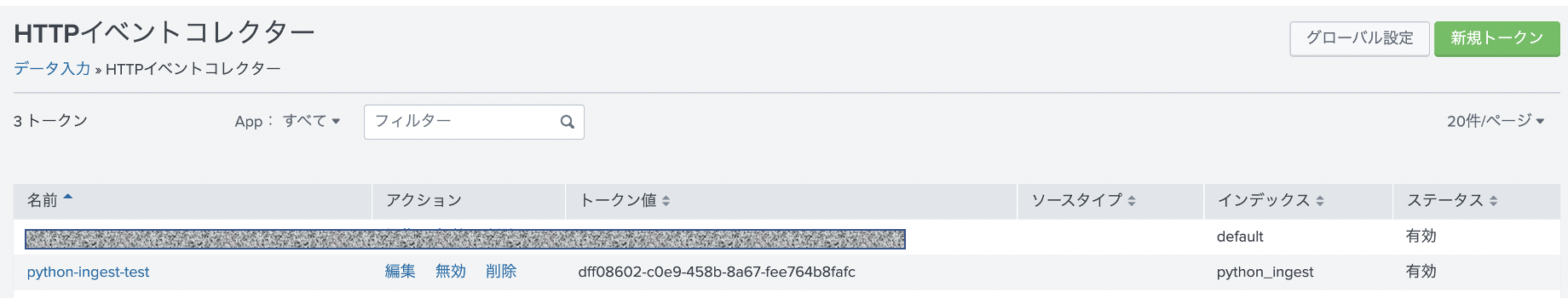

[設定] - [データ入力] - [HTTP Event Collector] と進みます。

右上の グローバル設定をクリックします。全トークンを有効にして、HTTPポート (default 8088)を確認します。SSLは有効が推奨ですが、証明書がないとワーニングが上がります。(ワーニングを無視もできますが)

1-2. Token作成

次に、Token作成をします。 一つ前の画面で右上の「新規トークン」をクリックします。

Tokenの名前を入力します。(あとはそのままでOK)

次に進んで、保存するIndexを指定します。ソースタイプは json形式になるので「自動」のままで大丈夫です。

必要に応じてIndexを新規作成して選択します。(既存のインデックスでも問題ありません)1-3. Tokenの確認

HTTP イベントコレクターの画面に戻ると、作成したトークンが確認できます。このトークンを後ほど利用します。

2. curl を使ったデータ取り込みテスト

次に RestAPIでデータが取り込めるか curlを使ってチェックします。

以下のドキュメントにサンプルがあるので、そちらを参考に実行してみます。, を変更ください。

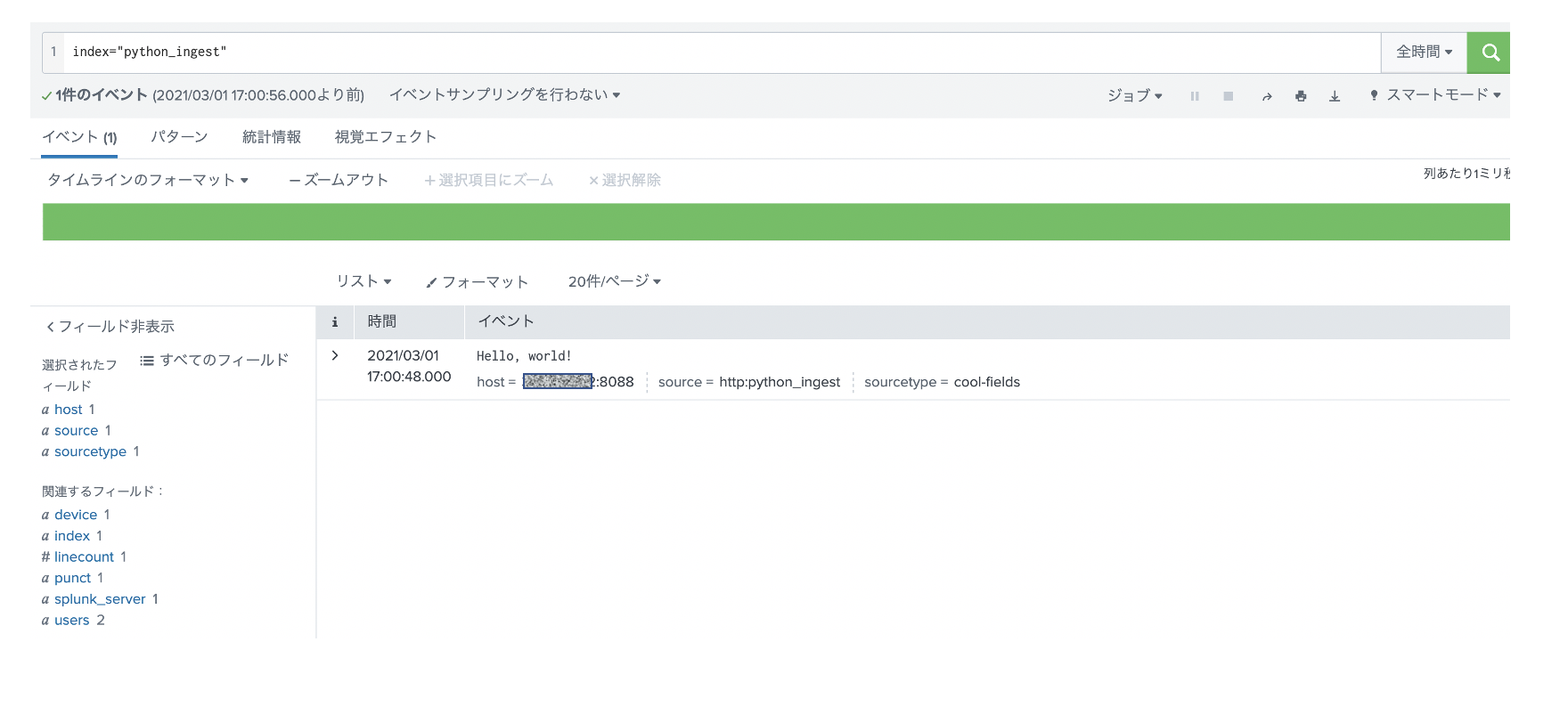

curl -k "https://<Splunk-server>:8088/services/collector/event" \ -H "Authorization: Splunk <TOKEN>" \ -d '{"event": "Hello, world!", "sourcetype": "cool-fields", "fields": {"device": "macbook", "users": ["joe", "bob"]}}'無事にデータを取り込めてますね。

3. pythonでの実装

curlでできることは、pythonでも行けるので、実装は簡単なのですが、シングルイベントではなく、複数イベントを取り込む必要があるので、そのあたりを実装する必要があります。

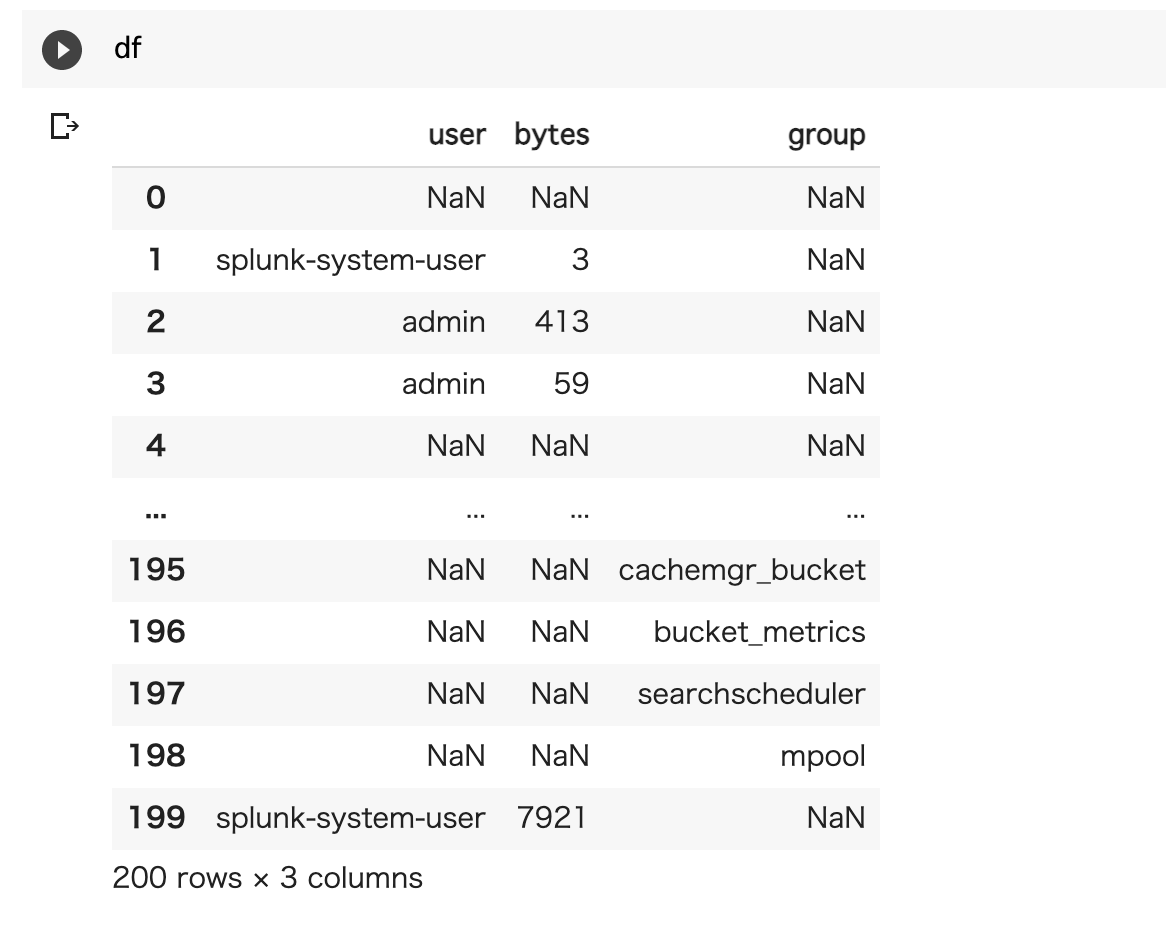

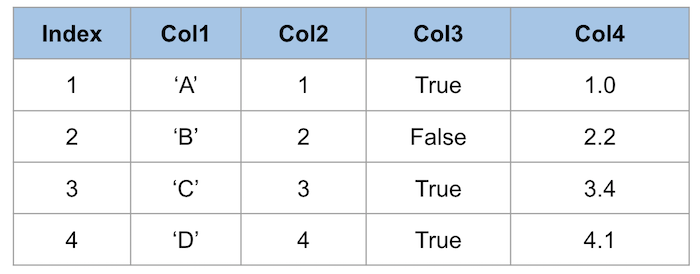

今回は、データフレーム形式のデータを、Splunkに取り込むまでを実装したいと思います。

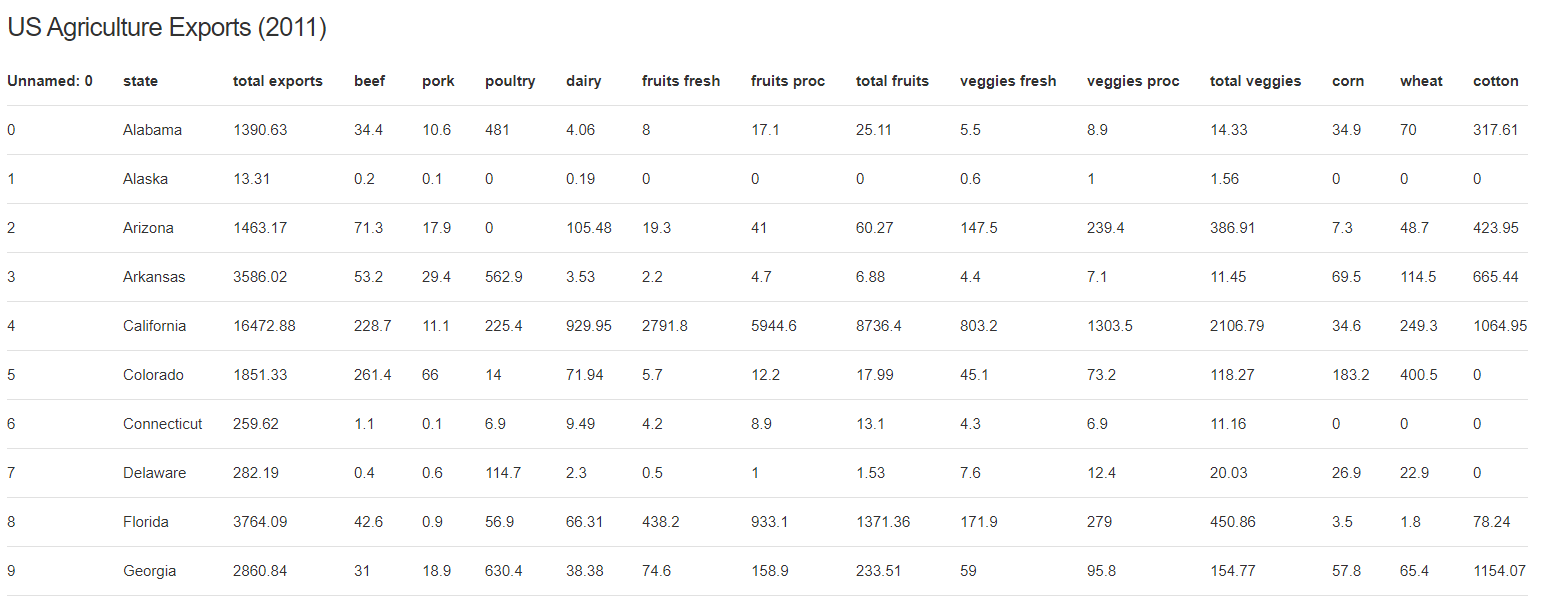

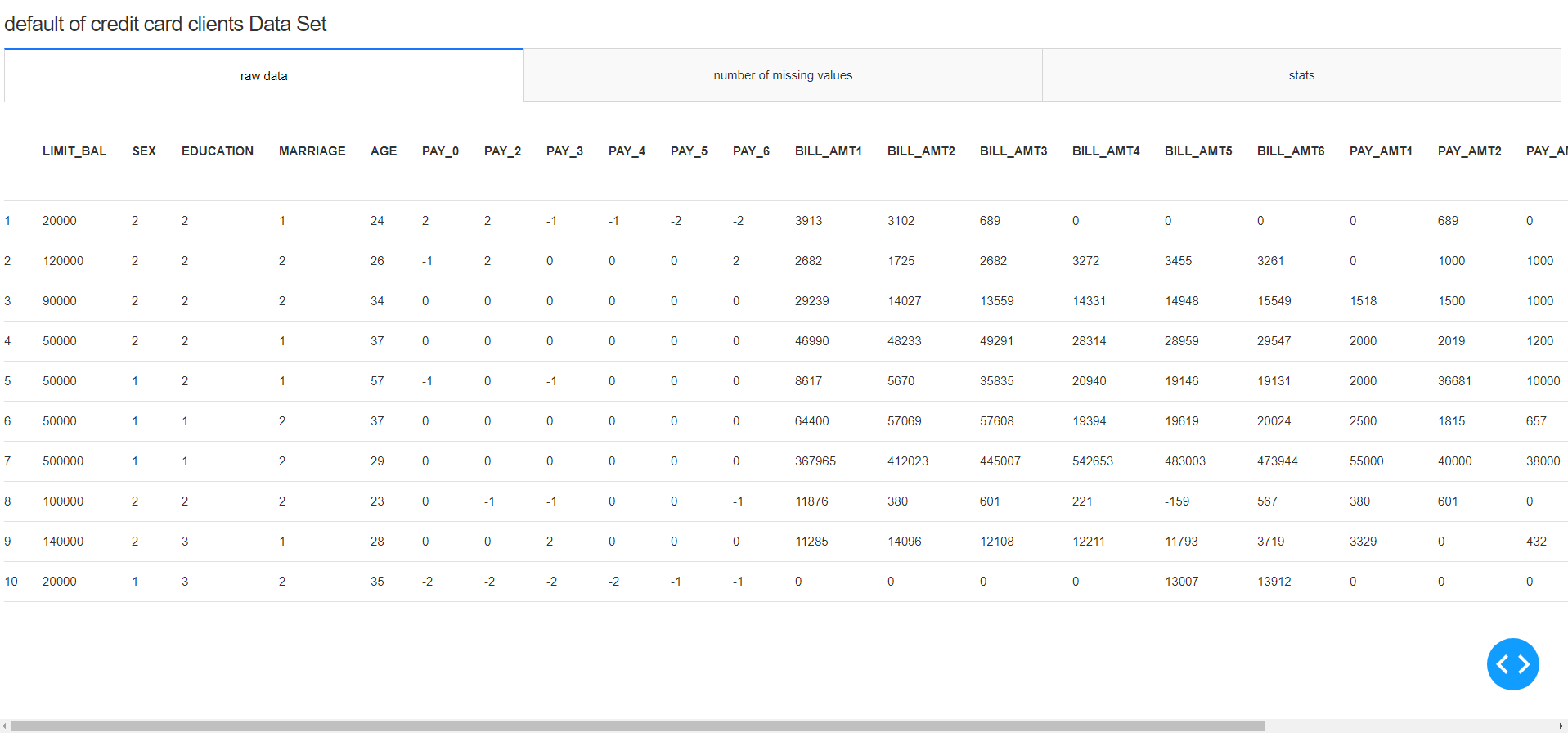

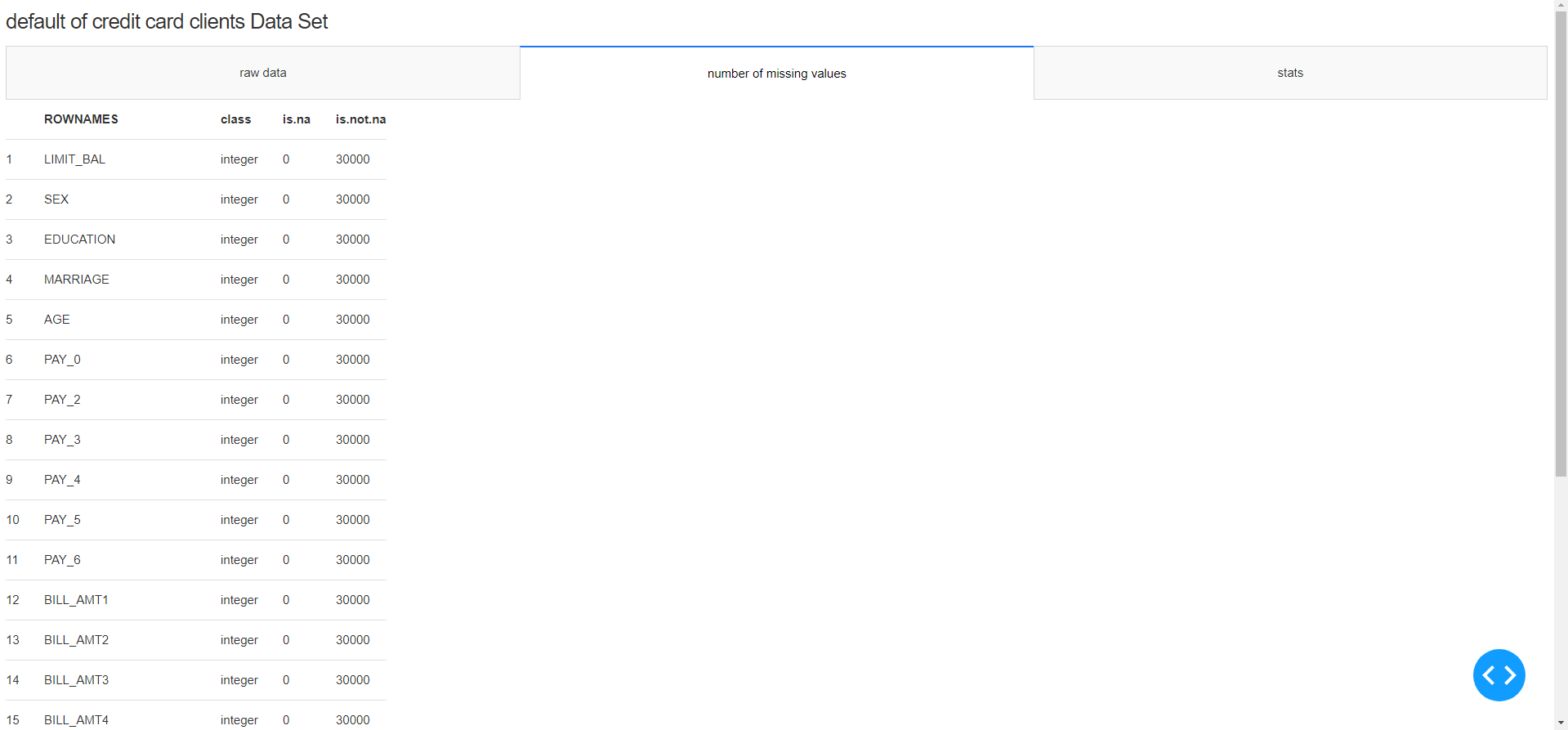

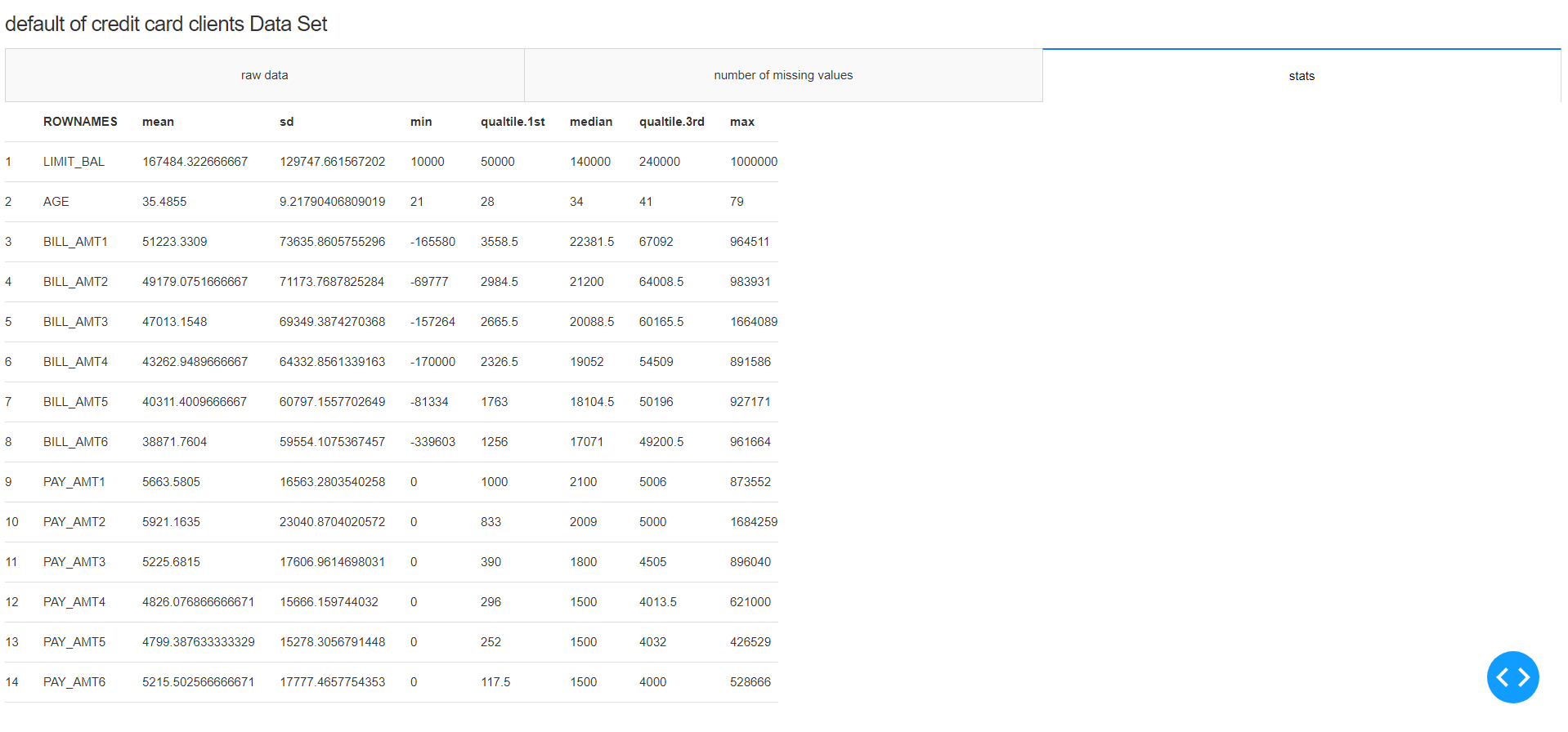

元のサンプルデータはこんな感じ(NULLが多いなー)

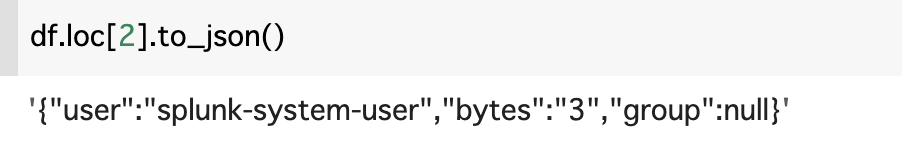

SpunkにHECで入れるためには、 rawデータもしくは、jsonフォーマットである必要があります。今回はjsonとして取り込もうと思います。

その場合、to_json()を使うことでjsonに変換できます。

これを for文を使って200件変換したデータをSplunkに取り込みたいと思います。

curlのコマンドを pythonで変換して、先ほどのデータをjsonに変換したものをループでHECに飛ばしてます。今回は証明書をセットしていないので、verify=f としてるので、ワーニングが出ますが今回は無視します。下のコードのうち、<TOKEN値>と<Server> を変更ください。

# HEC を使ったデータ投入 # Splunk Cloudの場合 443 ポートになります。 TOKEN = "<TOKEN value>" import requests headers = { 'Authorization': 'Splunk ' + TOKEN, } for i in range(len(df.index)): data = '{"event": ' + df.loc[i].to_json() + '}' response = requests.post('https://<server>:8088/services/collector' , headers=headers, data=data, verify=False)実行結果はこちらです。先ほどcurlコマンドでテストしたデータもあるので、全部で201件あります。json形式なのでそのままパースされてフィールド抽出まで完了してます。

最後に

大量のデータの場合、このループの方法だと時間がかかりそうなのでバッチ方式を検討した方が良さそうですが、分析で利用するためにsplunkから抜き出して、その結果をまたsplunkにフィードバックするだけなら、この方法で十分利用できそうです。

いちいちファイルに書き込んで、アップロードして。という手間が省けていい感じ。

- 投稿日:2021-03-01T18:07:17+09:00

YouTube, Deepspeech, with Google Colaboratory [testing_0005] : DeepSpeech output ’json’ [0002]

deepSpeech の音認識結果を json で受け取ると、

transcripts 0 {'confidence': -1793.291259765625, 'words': [{'wor... 1 {'confidence': -87105.90625, 'words': [{'word'... 2 {'confidence': -87105.90625, 'words': [{'word'...こうなっていました。

これは、

import pandas as pd import json import pprint #from collections import OrderedDict with open ('/content/json (1).txt','r') as f: #jso = json.load(f, object_pairs_hook=OrderedDict) line = f.read() #jso = json.load(f) jso = pd.read_json(line) #print(jso) #jso = json.loads(line) pprint.pprint(jso)の結果ですが、 json をパースする方法は色々あるようですが、詳細に内容を見る前にどうなっているのかなーと開いてみるにはこの pandas で見るのが良さそうでした。

全部観ると、単語ごとの出現箇所のタイムと、尺のラップされたものになるので非常に長い行数、または一行でずー―――と続く文字列となります。

{'transcripts': [{'confidence': -1793.291259765625, 'words': [{'word': 'you', 'start_time': 0.56, 'duration': 0.12}, {'word': 'may', 'start_time': 0.74, 'duration': 0.14}, {'word': 'write', 'start_time': 1.0, 'duration': 0.2}, {'word': 'me', 'start_time': 1.3, 'duration': 0.16}, {'word': 'down', 'start_time': 1.54, 'duration': 0.18}, {'word': 'in', 'start_time': 1.84, 'duration': 0.1}, {'word': 'history', 'start_time': 2.0, 'duration': 1.06}, {'word': 'with', 'start_time': 3.12, 'duration': 0.12}, {'word': 'your', 'start_time': 3.26, 'duration': 0.16}, {'word': 'visit', 'start_time': 3.5, 'duration': 0.32}, {'word': 'wished', 'start_time': 3.86, 'duration': 0.38}, {'word': 'lines', 'start_time': 4.34, 'duration': 1.1}, {'word': 'you', 'start_time': 5.52, 'duration': 0.1}, {'word': 'may', 'start_time': 5.66, 'duration': 0.22}, {'word': 'try', 'start_time': 6.0, 'duration': 0.3}, {'word': 'me', 'start_time': 6.34, 'duration': 0.12}, {'word': 'in', 'start_time': 6.54, 'duration': 0.06}, {'word': 'the', 'start_time': 6.64, 'duration': 0.08}, {'word': 'very', 'start_time': 6.78, 'duration': 0.28}, {'word': 'dirt', 'start_time': 7.14, 'duration': 1.12}, {'word': 'but', 'start_time': 8.32, 'duration': 0.22}, {'word': 'still', 'start_time': 8.6, 'duration': 0.3}, {'word': 'like', 'start_time': 8.98, 'duration': 0.38}, {'word': 'dust', 'start_time': 9.48, 'duration': 1.48}, {'word': 'or', 'start_time': 11.1, 'duration': 1.68}, {'word': 'does', 'start_time': 12.86, 'duration': 0.24}, {'word': 'my', 'start_time': 13.16, 'duration': 0.24}, {'word': 'sauciness', 'start_time': 13.48, 'duration': 0.52}, {'word': 'upset', 'start_time': 14.06, 'duration': 0.38}, {'word': 'you', 'start_time': 14.46, 'duration': 0.72}, {'word': 'why', 'start_time': 15.36, 'duration': 0.14}, {'word': 'are', 'start_time': 15.64, 'duration': 0.12}, {'word': 'you', 'start_time': 15.8, 'duration': 0.12}, {'word': 'beside', 'start_time': 16.02, 'duration': 0.32}, {'word': 'with', 'start_time': 16.38, 'duration': 0.12}, {'word': 'gloom', 'start_time': 16.58, 'duration': 0.72}, {'word': 'to', 'start_time': 17.42, 'duration': 0.1}, {'word': 'cause', 'start_time': 17.58, 'duration': 0.22}, {'word': 'i', 'start_time': 17.88, 'duration': 0.54}, {'word': 'walk', 'start_time': 18.5, 'duration': 0.22}, {'word': 'in', 'start_time': 18.8, 'duration': 0.1}, {'word': 'the', 'start_time': 18.96, 'duration': 0.18}, {'word': 'i', 'start_time': 19.28, 'duration': 0.14}, {'word': 'have', 'start_time': 19.48, 'duration': 0.52}, {'word': 'oil', 'start_time': 20.18, 'duration': 0.38}, {'word': 'wells', 'start_time': 20.68, 'duration': 0.38}, {'word': 'pumping', 'start_time': 21.12, 'duration': 0.64}, {'word': 'my', 'start_time': 21.82, 'duration': 0.26}, {'word': 'living', 'start_time': 22.14, 'duration': 0.42}, {'word': 'room', 'start_time': 22.66, 'duration': 1.68}, {'word': 'sailors', 'start_time': 24.44, 'duration': 1.38}, {'word': 'and', 'start_time': 25.94, 'duration': 0.1}, {'word': 'like', 'start_time': 26.12, 'duration': 0.5}, {'word': 'songs', 'start_time': 26.72, 'duration': 0.32}, {'word': 'with', 'start_time': 27.1, 'duration': 0.2}, {'word': 'a', 'start_time': 27.44, 'duration': 0.1}, {'word': 'cuttenclips', 'start_time': 27.62, 'duration': 3.38}, {'word': 'springing', 'start_time': 31.02, 'duration': 0.48}, {'word': 'high', 'start_time': 31.66, 'duration': 1.2}, {'word': 'still', 'start_time': 32.92, 'duration': 0.2}, {'word': 'i', 'start_time': 33.24, 'duration': 0.14}, {'word': 'wore', 'start_time': 33.46, 'duration': 0.9}, {'word': 'did', 'start_time': 34.42, 'duration': 0.16}, {'word': 'you', 'start_time': 34.62, 'duration': 0.12}, {'word': 'want', 'start_time': 34.8, 'duration': 0.18}, {'word': 'to', 'start_time': 35.04, 'duration': 0.08}, {'word': 'see', 'start_time': 35.18, 'duration': 0.16}, {'word': 'me', 'start_time': 35.4, 'duration': 0.18}, {'word': 'broken', 'start_time': 35.64, 'duration': 1.2}, {'word': 'bowed', 'start_time': 37.0, 'duration': 0.4}, {'word': 'head', 'start_time': 37.5, 'duration': 0.22}, {'word': 'and', 'start_time': 37.82, 'duration': 0.14}, {'word': 'lord', 'start_time': 38.08, 'duration': 0.46}, {'word': 'eyes', 'start_time': 38.82, 'duration': 0.82}, {'word': 'soltali', 'start_time': 39.7, 'duration': 1.0}, {'word': 'down', 'start_time': 40.76, 'duration': 0.24}, {'word': 'like', 'start_time': 41.04, 'duration': 0.36}, {'word': 'pedrosan', 'start_time': 41.46, 'duration': 1.9}, {'word': 'by', 'start_time': 43.46, 'duration': 0.18}, {'word': 'my', 'start_time': 43.78, 'duration': 0.3}, {'word': 'soul', 'start_time': 44.18, 'duration': 0.3}, {'word': 'societaires', 'start_time': 44.5, 'duration': 2.74}, {'word': 'oudenard', 'start_time': 47.32, 'duration': 4.08}, {'word': 'isolated', 'start_time': 51.5, 'duration': 1.7}, {'word': 'as', 'start_time': 53.32, 'duration': 0.1}, {'word': 'if', 'start_time': 53.54, 'duration': 0.16}, {'word': 'i', 'start_time': 53.8, 'duration': 0.12}, {'word': 'have', 'start_time': 53.98, 'duration': 0.26}, {'word': 'gold', 'start_time': 54.36, 'duration': 0.46}, {'word': "man's", 'start_time': 54.98, 'duration': 0.36}, {'word': 'digging', 'start_time': 55.42, 'duration': 0.28}, {'word': 'in', 'start_time': 55.78, 'duration': 0.08}, {'word': 'my', 'start_time': 55.92, 'duration': 0.2}, {'word': 'own', 'start_time': 56.3, 'duration': 0.26}, {'word': 'back', 'start_time': 56.64, 'duration': 0.28}, {'word': 'yard', 'start_time': 57.0, 'duration': 1.12}, {'word': 'you', 'start_time': 58.16, 'duration': 0.12}, {'word': 'can', 'start_time': 58.34, 'duration': 0.16}, {'word': 'shoot', 'start_time': 58.54, 'duration': 0.24}, {'word': 'me', 'start_time': 58.82, 'duration': 0.14}, {'word': 'with', 'start_time': 59.0, 'duration': 0.16}, {'word': 'your', 'start_time': 59.22, 'duration': 0.18}, {'word': 'words', 'start_time': 59.54, 'duration': 0.76}, {'word': 'you', 'start_time': 60.36, 'duration': 0.14}, {'word': 'can', 'start_time': 60.56, 'duration': 0.2}, {'word': 'cut', 'start_time': 60.84, 'duration': 0.2}, {'word': 'me', 'start_time': 61.06, 'duration': 0.14}, {'word': 'with', 'start_time': 61.26, 'duration': 0.16}, {'word': 'your', 'start_time': 61.46, 'duration': 0.22}, {'word': 'lies', 'start_time': 61.84, 'duration': 0.76}, {'word': 'you', 'start_time': 62.66, 'duration': 0.14}, {'word': 'can', 'start_time': 62.86, 'duration': 0.28}, {'word': 'kill', 'start_time': 63.2, 'duration': 0.22}, {'word': 'me', 'start_time': 63.46, 'duration': 0.14}, {'word': 'with', 'start_time': 63.66, 'duration': 0.12}, {'word': 'your', 'start_time': 63.84, 'duration': 0.16}, {'word': 'hatefulness', 'start_time': 64.06, 'duration': 0.54}, {'word': 'but', 'start_time': 64.66, 'duration': 0.1}, {'word': 'just', 'start_time': 64.84, 'duration': 0.26}, {'word': 'like', 'start_time': 65.14, 'duration': 0.42}, {'word': 'life', 'start_time': 65.64, 'duration': 1.42}, {'word': 'i', 'start_time': 67.18, 'duration': 1.46}, {'word': 'does', 'start_time': 68.68, 'duration': 0.24}, {'word': 'my', 'start_time': 68.96, 'duration': 0.26}, {'word': 'senatorian', 'start_time': 69.28, 'duration': 12.02}, {'word': 'as', 'start_time': 81.4, 'duration': 0.18}, {'word': 'if', 'start_time': 81.72, 'duration': 0.22}, {'word': 'i', 'start_time': 82.06, 'duration': 0.1}, {'word': 'have', 'start_time': 82.22, 'duration': 0.26}, {'word': 'diamonds', 'start_time': 82.56, 'duration': 0.5}, {'word': 'at', 'start_time': 83.16, 'duration': 0.1}, {'word': 'the', 'start_time': 83.3, 'duration': 0.1}, {'word': 'meeting', 'start_time': 83.46, 'duration': 0.4}, {'word': 'of', 'start_time': 84.0, 'duration': 0.12}, {'word': 'my', 'start_time': 84.22, 'duration': 0.3}, {'word': 'time', 'start_time': 84.72, 'duration': 2.72}, {'word': 'out', 'start_time': 87.58, 'duration': 0.18}, {'word': 'of', 'start_time': 87.84, 'duration': 0.12}, {'word': 'the', 'start_time': 88.0, 'duration': 0.12}, {'word': 'huts', 'start_time': 88.18, 'duration': 0.28}, {'word': 'of', 'start_time': 88.56, 'duration': 0.12}, {'word': 'history', 'start_time': 88.76, 'duration': 0.74}, {'word': 'shame', 'start_time': 89.6, 'duration': 0.32}, {'word': 'i', 'start_time': 90.04, 'duration': 0.18}, {'word': 'rise', 'start_time': 90.38, 'duration': 1.2}, {'word': 'up', 'start_time': 91.7, 'duration': 0.1}, {'word': 'from', 'start_time': 91.84, 'duration': 0.16}, {'word': 'a', 'start_time': 92.14, 'duration': 0.08}, {'word': 'past', 'start_time': 92.28, 'duration': 0.34}, {'word': 'rooted', 'start_time': 92.7, 'duration': 0.36}, {'word': 'in', 'start_time': 93.18, 'duration': 0.18}, {'word': 'pain', 'start_time': 93.46, 'duration': 0.72}, {'word': 'i', 'start_time': 94.32, 'duration': 0.14}, {'word': 'ran', 'start_time': 94.54, 'duration': 0.94}, {'word': 'a', 'start_time': 95.62, 'duration': 0.06}, {'word': 'black', 'start_time': 95.72, 'duration': 0.26}, {'word': 'ocean', 'start_time': 96.06, 'duration': 0.56}, {'word': 'heaving', 'start_time': 96.74, 'duration': 0.44}, {'word': 'and', 'start_time': 97.28, 'duration': 0.22}, {'word': 'would', 'start_time': 97.74, 'duration': 0.92}, {'word': 'willingly', 'start_time': 98.76, 'duration': 1.32}, {'word': 'and', 'start_time': 100.22, 'duration': 0.14}, {'word': 'bearing', 'start_time': 100.44, 'duration': 0.3}, {'word': 'it', 'start_time': 100.82, 'duration': 1.8}, {'word': 'leaving', 'start_time': 102.66, 'duration': 0.36}, {'word': 'behind', 'start_time': 103.1, 'duration': 0.56}, {'word': 'it', 'start_time': 103.78, 'duration': 0.2}, {'word': 'of', 'start_time': 104.1, 'duration': 0.14}, {'word': 'terror', 'start_time': 104.32, 'duration': 0.64}, {'word': 'and', 'start_time': 105.1, 'duration': 0.32}, {'word': 'fear', 'start_time': 105.54, 'duration': 0.8}, {'word': 'as', 'start_time': 107.04, 'duration': 0.9}, {'word': 'into', 'start_time': 108.14, 'duration': 0.3}, {'word': 'a', 'start_time': 108.52, 'duration': 0.06}, {'word': 'daybreak', 'start_time': 108.64, 'duration': 0.54}, {'word': 'miraculously', 'start_time': 109.24, 'duration': 1.04}, {'word': 'clear', 'start_time': 110.34, 'duration': 1.26}, {'word': 'in', 'start_time': 111.74, 'duration': 1.42}, {'word': 'bringing', 'start_time': 113.22, 'duration': 0.42}, {'word': 'the', 'start_time': 113.7, 'duration': 0.1}, {'word': 'gifts', 'start_time': 113.86, 'duration': 0.32}, {'word': 'that', 'start_time': 114.24, 'duration': 0.22}, {'word': 'my', 'start_time': 114.56, 'duration': 0.18}, {'word': 'ancestors', 'start_time': 114.86, 'duration': 0.66}, {'word': 'gave', 'start_time': 115.66, 'duration': 0.8}, {'word': 'i', 'start_time': 116.64, 'duration': 0.12}, {'word': 'am', 'start_time': 116.84, 'duration': 0.14}, {'word': 'the', 'start_time': 117.06, 'duration': 0.24}, {'word': 'whole', 'start_time': 117.4, 'duration': 0.58}, {'word': 'and', 'start_time': 118.1, 'duration': 0.1}, {'word': 'the', 'start_time': 118.26, 'duration': 0.18}, {'word': 'dream', 'start_time': 118.54, 'duration': 0.78}, {'word': 'of', 'start_time': 119.38, 'duration': 0.1}, {'word': 'the', 'start_time': 119.54, 'duration': 0.22}, {'word': 'slave', 'start_time': 119.8, 'duration': 1.18}, {'word': 'and', 'start_time': 121.2, 'duration': 0.3}, {'word': 'so', 'start_time': 121.64, 'duration': 4.68}, {'word': 'that', 'start_time': 126.42, 'duration': 0.14}]}, {'confidence': -1795.8509521484375, 'words': [{'word': 'you', 'start_time': 0.56, 'duration': 0.12}, {'word': 'may', 'start_time': 0.74, 'duration': 0.14}, {'word': 'write', 'start_time': 1.0, 'duration': 0.2}, {'word': 'me', 'start_time': 1.3, 'duration': 0.16}, {'word': 'down', 'start_time': 1.54, 'duration': 0.18}, {'word': 'in', 'start_time': 1.84, 'duration': 0.1}, {'word': 'history', 'start_time': 2.0, 'duration': 1.06}, {'word': 'with', 'start_time': 3.12, 'duration': 0.12}, {'word': 'your', 'start_time': 3.26, 'duration': 0.16}, {'word': 'visit', 'start_time': 3.5, 'duration': 0.32}, {'word': 'wished', 'start_time': 3.86, 'duration': 0.38}, {'word': 'lines', 'start_time': 4.34, 'duration': 1.1}, {'word': 'you', 'start_time': 5.52, 'duration': 0.1}, {'word': 'may', 'start_time': 5.66, 'duration': 0.22}, {'word': 'try', 'start_time': 6.0, 'duration': 0.3}, {'word': 'me', 'start_time': 6.34, 'duration': 0.12}, {'word': 'in', 'start_time': 6.54, 'duration': 0.06}, {'word': 'the', 'start_time': 6.64, 'duration': 0.08}, {'word': 'very', 'start_time': 6.78, 'duration': 0.28}, {'word': 'dirt', 'start_time': 7.14, 'duration': 1.12}, {'word': 'but', 'start_time': 8.32, 'duration': 0.22}, {'word': 'still', 'start_time': 8.6, 'duration': 0.3}, {'word': 'like', 'start_time': 8.98, 'duration': 0.38}, {'word': 'dust', 'start_time': 9.48, 'duration': 1.48}, {'word': 'or', 'start_time': 11.1, 'duration': 1.68}, {'word': 'does', 'start_time': 12.86, 'duration': 0.24}, {'word': 'my', 'start_time': 13.16, 'duration': 0.24}, {'word': 'sauciness', 'start_time': 13.48, 'duration': 0.52}, {'word': 'upset', 'start_time': 14.06, 'duration': 0.38}, {'word': 'you', 'start_time': 14.46, 'duration': 0.72}, {'word': 'why', 'start_time': 15.36, 'duration': 0.14}, {'word': 'are', 'start_time': 15.64, 'duration': 0.12}, {'word': 'you', 'start_time': 15.8, 'duration': 0.12}, {'word': 'beside', 'start_time': 16.02, 'duration': 0.32}, {'word': 'with', 'start_time': 16.38, 'duration': 0.12}, {'word': 'gloom', 'start_time': 16.58, 'duration': 0.72}, {'word': 'to', 'start_time': 17.42, 'duration': 0.1}, {'word': 'cause', 'start_time': 17.58, 'duration': 0.22}, {'word': 'i', 'start_time': 17.88, 'duration': 0.54}, {'word': 'walk', 'start_time': 18.5, 'duration': 0.22}, {'word': 'in', 'start_time': 18.8, 'duration': 0.1}, {'word': 'the', 'start_time': 18.96, 'duration': 0.18}, {'word': 'i', 'start_time': 19.28, 'duration': 0.14}, {'word': 'have', 'start_time': 19.48, 'duration': 0.52}, {'word': 'oil', 'start_time': 20.18, 'duration': 0.38}, {'word': 'wells', 'start_time': 20.68, 'duration': 0.38}, {'word': 'pumping', 'start_time': 21.12, 'duration': 0.64}, {'word': 'my', 'start_time': 21.82, 'duration': 0.26}, {'word': 'living', 'start_time': 22.14, 'duration': 0.42}, {'word': 'room', 'start_time': 22.66, 'duration': 1.68}, {'word': 'sailors', 'start_time': 24.44, 'duration': 1.38}, {'word': 'and', 'start_time': 25.94, 'duration': 0.1}, {'word': 'like', 'start_time': 26.12, 'duration': 0.5}, {'word': 'songs', 'start_time': 26.72, 'duration': 0.32}, {'word': 'with', 'start_time': 27.1, 'duration': 0.2}, {'word': 'a', 'start_time': 27.44, 'duration': 0.1}, {'word': 'cuttenclips', 'start_time': 27.62, 'duration': 3.38}, {'word': 'springing', 'start_time': 31.02, 'duration': 0.48}, {'word': 'high', 'start_time': 31.66, 'duration': 1.2}, {'word': 'still', 'start_time': 32.92, 'duration': 0.2}, {'word': 'i', 'start_time': 33.24, 'duration': 0.14}, {'word': 'wore', 'start_time': 33.46, 'duration': 0.9}, {'word': 'did', 'start_time': 34.42, 'duration': 0.16}, {'word': 'you', 'start_time': 34.62, 'duration': 0.12}, {'word': 'want', 'start_time': 34.8, 'duration': 0.18}, {'word': 'to', 'start_time': 35.04, 'duration': 0.08}, {'word': 'see', 'start_time': 35.18, 'duration': 0.16}, {'word': 'me', 'start_time': 35.4, 'duration': 0.18}, {'word': 'broken', 'start_time': 35.64, 'duration': 1.2}, {'word': 'bowed', 'start_time': 37.0, 'duration': 0.4}, {'word': 'head', 'start_time': 37.5, 'duration': 0.22}, {'word': 'and', 'start_time': 37.82, 'duration': 0.14}, {'word': 'lord', 'start_time': 38.08, 'duration': 0.46}, {'word': 'eyes', 'start_time': 38.82, 'duration': 0.82}, {'word': 'soltali', 'start_time': 39.7, 'duration': 1.0}, {'word': 'down', 'start_time': 40.76, 'duration': 0.24}, {'word': 'like', 'start_time': 41.04, 'duration': 0.36}, {'word': 'pedrosan', 'start_time': 41.46, 'duration': 1.9}, {'word': 'by', 'start_time': 43.46, 'duration': 0.18}, {'word': 'my', 'start_time': 43.78, 'duration': 0.3}, {'word': 'soul', 'start_time': 44.18, 'duration': 0.3}, {'word': 'societaires', 'start_time': 44.5, 'duration': 2.74}, {'word': 'oudenard', 'start_time': 47.32, 'duration': 4.08}, {'word': 'isolated', 'start_time': 51.5, 'duration': 1.7}, {'word': 'as', 'start_time': 53.32, 'duration': 0.1}, {'word': 'if', 'start_time': 53.54, 'duration': 0.16}, {'word': 'i', 'start_time': 53.8, 'duration': 0.12}, {'word': 'have', 'start_time': 53.98, 'duration': 0.26}, {'word': 'gold', 'start_time': 54.36, 'duration': 0.46}, {'word': "man's", 'start_time': 54.98, 'duration': 0.36}, {'word': 'digging', 'start_time': 55.42, 'duration': 0.28}, {'word': 'in', 'start_time': 55.78, 'duration': 0.08}, {'word': 'my', 'start_time': 55.92, 'duration': 0.2}, {'word': 'own', 'start_time': 56.3, 'duration': 0.26}, {'word': 'back', 'start_time': 56.64, 'duration': 0.28}, {'word': 'yard', 'start_time': 57.0, 'duration': 1.12}, {'word': 'you', 'start_time': 58.16, 'duration': 0.12}, {'word': 'can', 'start_time': 58.34, 'duration': 0.16}, {'word': 'shoot', 'start_time': 58.54, 'duration': 0.24}, {'word': 'me', 'start_time': 58.82, 'duration': 0.14}, {'word': 'with', 'start_time': 59.0, 'duration': 0.16}, {'word': 'your', 'start_time': 59.22, 'duration': 0.18}, {'word': 'words', 'start_time': 59.54, 'duration': 0.76}, {'word': 'you', 'start_time': 60.36, 'duration': 0.14}, {'word': 'can', 'start_time': 60.56, 'duration': 0.2}, {'word': 'cut', 'start_time': 60.84, 'duration': 0.2}, {'word': 'me', 'start_time': 61.06, 'duration': 0.14}, {'word': 'with', 'start_time': 61.26, 'duration': 0.16}, {'word': 'your', 'start_time': 61.46, 'duration': 0.22}, {'word': 'lies', 'start_time': 61.84, 'duration': 0.76}, {'word': 'you', 'start_time': 62.66, 'duration': 0.14}, {'word': 'can', 'start_time': 62.86, 'duration': 0.28}, {'word': 'kill', 'start_time': 63.2, 'duration': 0.22}, {'word': 'me', 'start_time': 63.46, 'duration': 0.14}, {'word': 'with', 'start_time': 63.66, 'duration': 0.12}, {'word': 'your', 'start_time': 63.84, 'duration': 0.16}, {'word': 'hatefulness', 'start_time': 64.06, 'duration': 0.54}, {'word': 'but', 'start_time': 64.66, 'duration': 0.1}, {'word': 'just', 'start_time': 64.84, 'duration': 0.26}, {'word': 'like', 'start_time': 65.14, 'duration': 0.42}, {'word': 'life', 'start_time': 65.64, 'duration': 1.42}, {'word': 'i', 'start_time': 67.18, 'duration': 1.46}, {'word': 'does', 'start_time': 68.68, 'duration': 0.24}, {'word': 'my', 'start_time': 68.96, 'duration': 0.26}, {'word': 'senatorian', 'start_time': 69.28, 'duration': 12.02}, {'word': 'as', 'start_time': 81.4, 'duration': 0.18}, {'word': 'if', 'start_time': 81.72, 'duration': 0.22}, {'word': 'i', 'start_time': 82.06, 'duration': 0.1}, {'word': 'have', 'start_time': 82.22, 'duration': 0.26}, {'word': 'diamonds', 'start_time': 82.56, 'duration': 0.5}, {'word': 'at', 'start_time': 83.16, 'duration': 0.1}, {'word': 'the', 'start_time': 83.3, 'duration': 0.1}, {'word': 'meeting', 'start_time': 83.46, 'duration': 0.4}, {'word': 'of', 'start_time': 84.0, 'duration': 0.12}, {'word': 'my', 'start_time': 84.22, 'duration': 0.3}, {'word': 'time', 'start_time': 84.72, 'duration': 2.72}, {'word': 'out', 'start_time': 87.58, 'duration': 0.18}, {'word': 'of', 'start_time': 87.84, 'duration': 0.12}, {'word': 'the', 'start_time': 88.0, 'duration': 0.12}, {'word': 'huts', 'start_time': 88.18, 'duration': 0.28}, {'word': 'of', 'start_time': 88.56, 'duration': 0.12}, {'word': 'history', 'start_time': 88.76, 'duration': 0.74}, {'word': 'shame', 'start_time': 89.6, 'duration': 0.32}, {'word': 'i', 'start_time': 90.04, 'duration': 0.18}, {'word': 'rise', 'start_time': 90.38, 'duration': 1.2}, {'word': 'up', 'start_time': 91.7, 'duration': 0.1}, {'word': 'from', 'start_time': 91.84, 'duration': 0.16}, {'word': 'a', 'start_time': 92.14, 'duration': 0.08}, {'word': 'past', 'start_time': 92.28, 'duration': 0.34}, {'word': 'rooted', 'start_time': 92.7, 'duration': 0.36}, {'word': 'in', 'start_time': 93.18, 'duration': 0.18}, {'word': 'pain', 'start_time': 93.46, 'duration': 0.72}, {'word': 'i', 'start_time': 94.32, 'duration': 0.14}, {'word': 'ran', 'start_time': 94.54, 'duration': 0.94}, {'word': 'a', 'start_time': 95.62, 'duration': 0.06}, {'word': 'black', 'start_time': 95.72, 'duration': 0.26}, {'word': 'ocean', 'start_time': 96.06, 'duration': 0.56}, {'word': 'heaving', 'start_time': 96.74, 'duration': 0.44}, {'word': 'and', 'start_time': 97.28, 'duration': 0.22}, {'word': 'would', 'start_time': 97.74, 'duration': 0.92}, {'word': 'willingly', 'start_time': 98.76, 'duration': 1.32}, {'word': 'and', 'start_time': 100.22, 'duration': 0.14}, {'word': 'bearing', 'start_time': 100.44, 'duration': 0.3}, {'word': 'it', 'start_time': 100.82, 'duration': 1.8}, {'word': 'leaving', 'start_time': 102.66, 'duration': 0.36}, {'word': 'behind', 'start_time': 103.1, 'duration': 0.56}, {'word': 'it', 'start_time': 103.78, 'duration': 0.2}, {'word': 'of', 'start_time': 104.1, 'duration': 0.14}, {'word': 'terror', 'start_time': 104.32, 'duration': 0.64}, {'word': 'and', 'start_time': 105.1, 'duration': 0.32}, {'word': 'fear', 'start_time': 105.54, 'duration': 0.8}, {'word': 'as', 'start_time': 107.04, 'duration': 0.9}, {'word': 'into', 'start_time': 108.14, 'duration': 0.3}, {'word': 'a', 'start_time': 108.52, 'duration': 0.06}, {'word': 'daybreak', 'start_time': 108.64, 'duration': 0.54}, {'word': 'miraculously', 'start_time': 109.24, 'duration': 1.04}, {'word': 'clear', 'start_time': 110.34, 'duration': 1.26}, {'word': 'in', 'start_time': 111.74, 'duration': 1.42}, {'word': 'bringing', 'start_time': 113.22, 'duration': 0.42}, {'word': 'the', 'start_time': 113.7, 'duration': 0.1}, {'word': 'gifts', 'start_time': 113.86, 'duration': 0.32}, {'word': 'that', 'start_time': 114.24, 'duration': 0.22}, {'word': 'my', 'start_time': 114.56, 'duration': 0.18}, {'word': 'ancestors', 'start_time': 114.86, 'duration': 0.66}, {'word': 'gave', 'start_time': 115.66, 'duration': 0.8}, {'word': 'i', 'start_time': 116.64, 'duration': 0.12}, {'word': 'am', 'start_time': 116.84, 'duration': 0.14}, {'word': 'the', 'start_time': 117.06, 'duration': 0.24}, {'word': 'whole', 'start_time': 117.4, 'duration': 0.58}, {'word': 'and', 'start_time': 118.1, 'duration': 0.1}, {'word': 'the', 'start_time': 118.26, 'duration': 0.18}, {'word': 'dream', 'start_time': 118.54, 'duration': 0.78}, {'word': 'of', 'start_time': 119.38, 'duration': 0.1}, {'word': 'the', 'start_time': 119.54, 'duration': 0.22}, {'word': 'slave', 'start_time': 119.8, 'duration': 1.18}, {'word': 'and', 'start_time': 121.2, 'duration': 0.3}, {'word': 'so', 'start_time': 121.64, 'duration': 4.68}, {'word': 'then', 'start_time': 126.42, 'duration': 0.14}]}, {'confidence': -1796.1273193359375, 'words': [{'word': 'you', 'start_time': 0.56, 'duration': 0.12}, {'word': 'may', 'start_time': 0.74, 'duration': 0.14}, {'word': 'write', 'start_time': 1.0, 'duration': 0.2}, {'word': 'me', 'start_time': 1.3, 'duration': 0.16}, {'word': 'down', 'start_time': 1.54, 'duration': 0.18}, {'word': 'in', 'start_time': 1.84, 'duration': 0.1}, {'word': 'history', 'start_time': 2.0, 'duration': 1.06}, {'word': 'with', 'start_time': 3.12, 'duration': 0.12}, {'word': 'your', 'start_time': 3.26, 'duration': 0.16}, {'word': 'visit', 'start_time': 3.5, 'duration': 0.32}, {'word': 'wished', 'start_time': 3.86, 'duration': 0.38}, {'word': 'lines', 'start_time': 4.34, 'duration': 1.1}, {'word': 'you', 'start_time': 5.52, 'duration': 0.1}, {'word': 'may', 'start_time': 5.66, 'duration': 0.22}, {'word': 'try', 'start_time': 6.0, 'duration': 0.3}, {'word': 'me', 'start_time': 6.34, 'duration': 0.12}, {'word': 'in', 'start_time': 6.54, 'duration': 0.06}, {'word': 'the', 'start_time': 6.64, 'duration': 0.08}, {'word': 'very', 'start_time': 6.78, 'duration': 0.28}, {'word': 'dirt', 'start_time': 7.14, 'duration': 1.12}, {'word': 'but', 'start_time': 8.32, 'duration': 0.22}, {'word': 'still', 'start_time': 8.6, 'duration': 0.3}, {'word': 'like', 'start_time': 8.98, 'duration': 0.38}, {'word': 'dust', 'start_time': 9.48, 'duration': 1.48}, {'word': 'or', 'start_time': 11.1, 'duration': 1.68}, {'word': 'does', 'start_time': 12.86, 'duration': 0.24}, {'word': 'my', 'start_time': 13.16, 'duration': 0.24}, {'word': 'sauciness', 'start_time': 13.48, 'duration': 0.52}, {'word': 'upset', 'start_time': 14.06, 'duration': 0.38}, {'word': 'you', 'start_time': 14.46, 'duration': 0.72}, {'word': 'why', 'start_time': 15.36, 'duration': 0.14}, {'word': 'are', 'start_time': 15.64, 'duration': 0.12}, {'word': 'you', 'start_time': 15.8, 'duration': 0.12}, {'word': 'beside', 'start_time': 16.02, 'duration': 0.32}, {'word': 'with', 'start_time': 16.38, 'duration': 0.12}, {'word': 'gloom', 'start_time': 16.58, 'duration': 0.72}, {'word': 'to', 'start_time': 17.42, 'duration': 0.1}, {'word': 'cause', 'start_time': 17.58, 'duration': 0.22}, {'word': 'i', 'start_time': 17.88, 'duration': 0.54}, {'word': 'walk', 'start_time': 18.5, 'duration': 0.22}, {'word': 'in', 'start_time': 18.8, 'duration': 0.1}, {'word': 'the', 'start_time': 18.96, 'duration': 0.18}, {'word': 'i', 'start_time': 19.28, 'duration': 0.14}, {'word': 'have', 'start_time': 19.48, 'duration': 0.52}, {'word': 'oil', 'start_time': 20.18, 'duration': 0.38}, {'word': 'wells', 'start_time': 20.68, 'duration': 0.38}, {'word': 'pumping', 'start_time': 21.12, 'duration': 0.64}, {'word': 'my', 'start_time': 21.82, 'duration': 0.26}, {'word': 'living', 'start_time': 22.14, 'duration': 0.42}, {'word': 'room', 'start_time': 22.66, 'duration': 1.68}, {'word': 'sailors', 'start_time': 24.44, 'duration': 1.38}, {'word': 'and', 'start_time': 25.94, 'duration': 0.1}, {'word': 'like', 'start_time': 26.12, 'duration': 0.5}, {'word': 'songs', 'start_time': 26.72, 'duration': 0.32}, {'word': 'with', 'start_time': 27.1, 'duration': 0.2}, {'word': 'a', 'start_time': 27.44, 'duration': 0.1}, {'word': 'cuttenclips', 'start_time': 27.62, 'duration': 3.38}, {'word': 'springing', 'start_time': 31.02, 'duration': 0.48}, {'word': 'high', 'start_time': 31.66, 'duration': 1.2}, {'word': 'still', 'start_time': 32.92, 'duration': 0.2}, {'word': 'i', 'start_time': 33.24, 'duration': 0.14}, {'word': 'wore', 'start_time': 33.46, 'duration': 0.9}, {'word': 'did', 'start_time': 34.42, 'duration': 0.16}, {'word': 'you', 'start_time': 34.62, 'duration': 0.12}, {'word': 'want', 'start_time': 34.8, 'duration': 0.18}, {'word': 'to', 'start_time': 35.04, 'duration': 0.08}, {'word': 'see', 'start_time': 35.18, 'duration': 0.16}, {'word': 'me', 'start_time': 35.4, 'duration': 0.18}, {'word': 'broken', 'start_time': 35.64, 'duration': 1.2}, {'word': 'bowed', 'start_time': 37.0, 'duration': 0.4}, {'word': 'head', 'start_time': 37.5, 'duration': 0.22}, {'word': 'and', 'start_time': 37.82, 'duration': 0.14}, {'word': 'lord', 'start_time': 38.08, 'duration': 0.46}, {'word': 'eyes', 'start_time': 38.82, 'duration': 0.82}, {'word': 'soltali', 'start_time': 39.7, 'duration': 1.0}, {'word': 'down', 'start_time': 40.76, 'duration': 0.24}, {'word': 'like', 'start_time': 41.04, 'duration': 0.36}, {'word': 'pedrosan', 'start_time': 41.46, 'duration': 1.9}, {'word': 'by', 'start_time': 43.46, 'duration': 0.18}, {'word': 'my', 'start_time': 43.78, 'duration': 0.3}, {'word': 'soul', 'start_time': 44.18, 'duration': 0.3}, {'word': 'societaires', 'start_time': 44.5, 'duration': 2.74}, {'word': 'oudenard', 'start_time': 47.32, 'duration': 4.08}, {'word': 'isolated', 'start_time': 51.5, 'duration': 1.7}, {'word': 'as', 'start_time': 53.32, 'duration': 0.1}, {'word': 'if', 'start_time': 53.54, 'duration': 0.16}, {'word': 'i', 'start_time': 53.8, 'duration': 0.12}, {'word': 'have', 'start_time': 53.98, 'duration': 0.26}, {'word': 'gold', 'start_time': 54.36, 'duration': 0.46}, {'word': "man's", 'start_time': 54.98, 'duration': 0.36}, {'word': 'digging', 'start_time': 55.42, 'duration': 0.28}, {'word': 'in', 'start_time': 55.78, 'duration': 0.08}, {'word': 'my', 'start_time': 55.92, 'duration': 0.2}, {'word': 'own', 'start_time': 56.3, 'duration': 0.26}, {'word': 'back', 'start_time': 56.64, 'duration': 0.28}, {'word': 'yard', 'start_time': 57.0, 'duration': 1.12}, {'word': 'you', 'start_time': 58.16, 'duration': 0.12}, {'word': 'can', 'start_time': 58.34, 'duration': 0.16}, {'word': 'shoot', 'start_time': 58.54, 'duration': 0.24}, {'word': 'me', 'start_time': 58.82, 'duration': 0.14}, {'word': 'with', 'start_time': 59.0, 'duration': 0.16}, {'word': 'your', 'start_time': 59.22, 'duration': 0.18}, {'word': 'words', 'start_time': 59.54, 'duration': 0.76}, {'word': 'you', 'start_time': 60.36, 'duration': 0.14}, {'word': 'can', 'start_time': 60.56, 'duration': 0.2}, {'word': 'cut', 'start_time': 60.84, 'duration': 0.2}, {'word': 'me', 'start_time': 61.06, 'duration': 0.14}, {'word': 'with', 'start_time': 61.26, 'duration': 0.16}, {'word': 'your', 'start_time': 61.46, 'duration': 0.22}, {'word': 'lies', 'start_time': 61.84, 'duration': 0.76}, {'word': 'you', 'start_time': 62.66, 'duration': 0.14}, {'word': 'can', 'start_time': 62.86, 'duration': 0.28}, {'word': 'kill', 'start_time': 63.2, 'duration': 0.22}, {'word': 'me', 'start_time': 63.46, 'duration': 0.14}, {'word': 'with', 'start_time': 63.66, 'duration': 0.12}, {'word': 'your', 'start_time': 63.84, 'duration': 0.16}, {'word': 'hatefulness', 'start_time': 64.06, 'duration': 0.54}, {'word': 'but', 'start_time': 64.66, 'duration': 0.1}, {'word': 'just', 'start_time': 64.84, 'duration': 0.26}, {'word': 'like', 'start_time': 65.14, 'duration': 0.42}, {'word': 'life', 'start_time': 65.64, 'duration': 1.42}, {'word': 'i', 'start_time': 67.18, 'duration': 1.46}, {'word': 'does', 'start_time': 68.68, 'duration': 0.24}, {'word': 'my', 'start_time': 68.96, 'duration': 0.26}, {'word': 'senatorian', 'start_time': 69.28, 'duration': 12.02}, {'word': 'as', 'start_time': 81.4, 'duration': 0.18}, {'word': 'if', 'start_time': 81.72, 'duration': 0.22}, {'word': 'i', 'start_time': 82.06, 'duration': 0.1}, {'word': 'have', 'start_time': 82.22, 'duration': 0.26}, {'word': 'diamonds', 'start_time': 82.56, 'duration': 0.5}, {'word': 'at', 'start_time': 83.16, 'duration': 0.1}, {'word': 'the', 'start_time': 83.3, 'duration': 0.1}, {'word': 'meeting', 'start_time': 83.46, 'duration': 0.4}, {'word': 'of', 'start_time': 84.0, 'duration': 0.12}, {'word': 'my', 'start_time': 84.22, 'duration': 0.3}, {'word': 'time', 'start_time': 84.72, 'duration': 2.72}, {'word': 'out', 'start_time': 87.58, 'duration': 0.18}, {'word': 'of', 'start_time': 87.84, 'duration': 0.12}, {'word': 'the', 'start_time': 88.0, 'duration': 0.12}, {'word': 'huts', 'start_time': 88.18, 'duration': 0.28}, {'word': 'of', 'start_time': 88.56, 'duration': 0.12}, {'word': 'history', 'start_time': 88.76, 'duration': 0.74}, {'word': 'shame', 'start_time': 89.6, 'duration': 0.32}, {'word': 'i', 'start_time': 90.04, 'duration': 0.18}, {'word': 'rise', 'start_time': 90.38, 'duration': 1.2}, {'word': 'up', 'start_time': 91.7, 'duration': 0.1}, {'word': 'from', 'start_time': 91.84, 'duration': 0.16}, {'word': 'a', 'start_time': 92.14, 'duration': 0.08}, {'word': 'past', 'start_time': 92.28, 'duration': 0.34}, {'word': 'rooted', 'start_time': 92.7, 'duration': 0.36}, {'word': 'in', 'start_time': 93.18, 'duration': 0.18}, {'word': 'pain', 'start_time': 93.46, 'duration': 0.72}, {'word': 'i', 'start_time': 94.32, 'duration': 0.14}, {'word': 'ran', 'start_time': 94.54, 'duration': 0.94}, {'word': 'a', 'start_time': 95.62, 'duration': 0.06}, {'word': 'black', 'start_time': 95.72, 'duration': 0.26}, {'word': 'ocean', 'start_time': 96.06, 'duration': 0.56}, {'word': 'heaving', 'start_time': 96.74, 'duration': 0.44}, {'word': 'and', 'start_time': 97.28, 'duration': 0.22}, {'word': 'would', 'start_time': 97.74, 'duration': 0.92}, {'word': 'willingly', 'start_time': 98.76, 'duration': 1.32}, {'word': 'and', 'start_time': 100.22, 'duration': 0.14}, {'word': 'bearing', 'start_time': 100.44, 'duration': 0.3}, {'word': 'it', 'start_time': 100.82, 'duration': 1.8}, {'word': 'leaving', 'start_time': 102.66, 'duration': 0.36}, {'word': 'behind', 'start_time': 103.1, 'duration': 0.56}, {'word': 'it', 'start_time': 103.78, 'duration': 0.2}, {'word': 'of', 'start_time': 104.1, 'duration': 0.14}, {'word': 'terror', 'start_time': 104.32, 'duration': 0.64}, {'word': 'and', 'start_time': 105.1, 'duration': 0.32}, {'word': 'fear', 'start_time': 105.54, 'duration': 0.8}, {'word': 'as', 'start_time': 107.04, 'duration': 0.9}, {'word': 'into', 'start_time': 108.14, 'duration': 0.3}, {'word': 'a', 'start_time': 108.52, 'duration': 0.06}, {'word': 'daybreak', 'start_time': 108.64, 'duration': 0.54}, {'word': 'miraculously', 'start_time': 109.24, 'duration': 1.04}, {'word': 'clear', 'start_time': 110.34, 'duration': 1.26}, {'word': 'in', 'start_time': 111.74, 'duration': 1.42}, {'word': 'bringing', 'start_time': 113.22, 'duration': 0.42}, {'word': 'the', 'start_time': 113.7, 'duration': 0.1}, {'word': 'gifts', 'start_time': 113.86, 'duration': 0.32}, {'word': 'that', 'start_time': 114.24, 'duration': 0.22}, {'word': 'my', 'start_time': 114.56, 'duration': 0.18}, {'word': 'ancestors', 'start_time': 114.86, 'duration': 0.66}, {'word': 'gave', 'start_time': 115.66, 'duration': 0.8}, {'word': 'i', 'start_time': 116.64, 'duration': 0.12}, {'word': 'am', 'start_time': 116.84, 'duration': 0.14}, {'word': 'the', 'start_time': 117.06, 'duration': 0.24}, {'word': 'whole', 'start_time': 117.4, 'duration': 0.58}, {'word': 'and', 'start_time': 118.1, 'duration': 0.1}, {'word': 'the', 'start_time': 118.26, 'duration': 0.18}, {'word': 'dream', 'start_time': 118.54, 'duration': 0.78}, {'word': 'of', 'start_time': 119.38, 'duration': 0.1}, {'word': 'the', 'start_time': 119.54, 'duration': 0.22}, {'word': 'slaves', 'start_time': 119.8, 'duration': 1.18}, {'word': 'and', 'start_time': 121.2, 'duration': 0.3}, {'word': 'so', 'start_time': 121.64, 'duration': 4.68}, {'word': 'then', 'start_time': 126.42, 'duration': 0.14}]}]}ちょっとまだ

confidenceを理解していないのですが、きっと認識の候補かなぁ...と仮定して、['transcripts'][0]つまりtranscripts 0 {'confidence': -1793.291259765625, 'words': [{'wor...のなかのものを抽出して、json から SubRip 形式の(つまり YouTube でデフォルトで使われている字幕のファイル形式ですが)ファイルに変換する python のコードを考えてみました。GoogleColab 用ですが、別にこれはたんに json ファイル、ここではなぜか、

.jsonではなく.txtにしていますが、から json をパースするプログラムなので、ローカル用に変更して実行しても十分速いのではないかなと思います。やってないので、「(やっ)タラ、(もし、や)レバ」です。import json import datetime from google.colab import files import sys #uploaded = files.upload() upfilename = '/content/json (1).txt' #for fn in uploaded.keys(): # print('User uploaded file "{name}" with length {length} bytes'.format(name=fn, length=len(uploaded[fn]))) # upfilename = fn def fmttime(seconds): secs = seconds #millisecs / 1000.0 d = datetime.timedelta(seconds=secs) t = (datetime.datetime.min + d).time() milli = t.strftime('%f')[:3] value = t.strftime('%H:%M:%S,') + milli return value original_stdout = sys.stdout #""" stdout backup """ filename = 'subtitle.srt' #""" print subtitle text to this file """ with open(upfilename, 'r') as up_f: line = up_f.read() jso = json.loads(line) ###print(jso['transcripts'][0]['words']) with open(filename,'w',encoding='utf8') as down_f: #sys.stdout = down_f #""" stdout to file """" totaltime = 0 sentence = [] endtime = '' starttime = '' lastword_time = 0 lineNum = 1 for i,ob in enumerate(jso['transcripts'][0]['words']): ###print(ob) for count,key in enumerate(ob): if key == 'word': ###print(jso['transcripts'][0]['words'][i][key]) sentence.append(ob[key]) ###print(*sentence) elif key == 'start_time': ###print(jso['transcripts'][0]['words'][i][key]) time = ob[key] if time - lastword_time >= 4: # 4 secons silence ### block > totaltime = 0 endtime = fmttime(lastword_time) print(lineNum) lineNum += 1 print(starttime,'->',endtime) temp = sentence.pop() # this word goes to next caption kotoba = '' for word in sentence: kotoba += word + ' ' print(kotoba.rstrip()) print() sentence.clear() ### < block sentence.append(temp) # new caption p_time = time starttime = fmttime(p_time) elif len(sentence) == 1 : starttime = fmttime(time) p_time = time elif key == 'duration': ###print(jso['transcripts'][0]['words'][i][key]) totaltime += ob[key] lastword_time = p_time + totaltime #print('in :',fmttime(time),'>>',*sentence) #print('end :',fmttime(p_time+totaltime)) if totaltime > 9: # 6 seconds speech gose to 1 caption ### block > totaltime = 0 endtime = fmttime(lastword_time) print(lineNum) lineNum += 1 print(starttime,'->',endtime) kotoba = '' for word in sentence: kotoba += word + ' ' print(kotoba.rstrip()) print() sentence.clear() ### < block #sys.stdout = original_stdout #""" stdout back """ #files.download(filename) #""" download .srt file """SubRip の形式であれば(あればね。これがちゃんとSubRipの要件満たしていたら)、字幕編集のプログラムで見ることもできるでしょう、きっと、たぶんね。

(字幕編集プログラムについては、

https://qiita.com/dauuricus/items/863dd4d087b3aff6455d )いまおもいついたのですが、上記のようにセンテンスで取り出さずに

word単位でタイムシートにすれば、認識したことばと位置をつかって、Tracker のようなシンセサイザーみたいなのがつくれそうですね。

というところでようやく理解したのだけれども mozilla はもしかして TTS のために STT をやってるのかな?センテンスで取り出すニーズを補完する方がわかりやすいのは、対比して VOSK と比較した場合、VOSKでは json から 'text' ですぐにセンテンスが抽出されるようになっている。なので VOSK では比較的簡単に字幕ぽいの抽出はできる。1confidence の意味がよくわからない。

なぜ文の評価のようになっているんだろうか?

https://discourse.mozilla.org/t/obtain-per-word-confidence-score/44969ドキュメントだと検索しても、なぜなのかについては出てこなさそうであったため、どうやって confidence 0,1,2 を word ごとに順に並べて表示するように json から取り出すか考えて、

def print_word(n) : for ob in jso['transcripts'][n]['words']: for key in ob: if key == 'word': print('confidence;',str(n)+':',ob[key]) n = n + 1 if n > 2: n = 0 p = ob.pop(key) #print('pop',p) print_word(n) break else: ob.pop(key) break print_word(0)ようやく期待したものにはなったが、並べて確かめると word の単語は3つともに同じであったりなかったりする。