- 投稿日:2020-10-21T23:32:20+09:00

Pythonってどんなプログラミング言語?

はじめに

どうも現在44歳の最近スケボーを始めたジジイです。

世間一般的には、まぁーいい歳、いいジジイです。興味を持ったものは実際に自分で経験してやってみる。行動する!!

という信念を掲げまして、

去年の終わり頃からプログラミングに興味を持ち、仕事をしながら現在某プログラミングスクールに通っています。こちらはもう終盤に入っている状況。

こちらではRubyやらjQueryやらRailsなどを学びWebアプリケーションをいくつか作ってきました。

また現在進行形で個人アプリを制作中でもあります。と、ここまでいろいろと勉強してきたんですが、無性にPythonというプログラミング言語が気になってしょうがない今日この頃!!

なぜか惹かれるこのPython...

Pythonってなんなんだ...

パ・イ・ソ・ン......?どうでもいい前置きが長くなりましたが、

こちらではプログラミング言語 Pythonについて学習した内容を備忘録として記載していきたいと思います。Pythonに興味を持った方々の参考になれば幸いでございます。

また、記載内容に間違いなどございましたら遠慮なくご指摘願います。

宜しくお願い致します。

Pythonの特徴

Pythonは1990年にグイド・ヴァンロッサムというオランダ人に開発されたプログラミング言語

文法がシンプルでわかりやすい、可読性が高い

汎用性の高いプログラミング言語なのでさまざまな開発が可能

オブジェクト指向言語である

専門的なライブラリが豊富にある

Pythonのライブラリは、数万個以上のライブラリが公開されています。

大きく分けると以下の様なライブラリがあるとのこと。

- 数値計算・信号処理・統計処理

- 画像処理・音声処理・動画処理

- ウェブ開発・サーバー・フレームワーク

- ネットワーク

- データベース

- ドライバ

- 自然言語処理

この様に多くのライブラリがありますので、効率的な開発をすることができる。

そして一例として、下記の様なサービスの構築に使われている模様。

- Youtube

- DropBox

- Blender

どんなことが出来るのか?

- 分別の自動化

- ルート最適化の自動化

- 自動応答

- 支払いの自動化

- データ収集の自動化

- データ記録の自動化

- 株の自動売買

- 仮想通貨の自動売買

- 支払いの自動化

- Webアプリケーション

- デスクトップアプリの開発

- 人工知能/機械学習の開発

- 植物やペットの監視システム

- おもちゃのAI戦車

- ドローンの自動操縦

と、詳しい内容は今回は省きますが、いろいろな事が出来るようですね。

そして、最後に、

『既存のパターン化された仕事は、これからどんどんロボットや人工知能搭載のソフトウェアに置き換わっていき、代わりに人工知能分野の開発者が必要とされています。

その結果、人工知能開発によく使われるPythonに人々が集まっているという状況があります。 その他にも、増え続けるビッグデータの経営資源化、スマホやウェアラブルによってより複雑になる個人の消費行動、セキュリティや自動運転のための画像解析技術、このようなことから今まさに時代はPythonを求めているのですね。』

とのことです。

これからどの様な時代が来るのか楽しみでありますね。

時代に乗り遅れない様に常に好奇心を持って新しいことにチャレンジして行こうと思います。

まとめ

検索していろいろ調べて見ましたが、まだまだ浅い部分しか触れてないので、これからいろいろと学習していきます。

だが、どうやって学習して行こうか考察中。

何かおすすめあればご教授のほど、よろしくお願い致します!!

参考記事

最近話題の言語【Python】でできる15のこと(2020年版)

【初心者向け】Pythonの特徴8選

Pythonとは?特徴やメリット・勉強法を解説【初心者向け】上記サイトを参考に書かせていただきました。ありがとうございましたm(_ _)m

- 投稿日:2020-10-21T23:28:24+09:00

行列から探して、編集してみよう

こんばんは(*´ω`)

昨日の延長です。

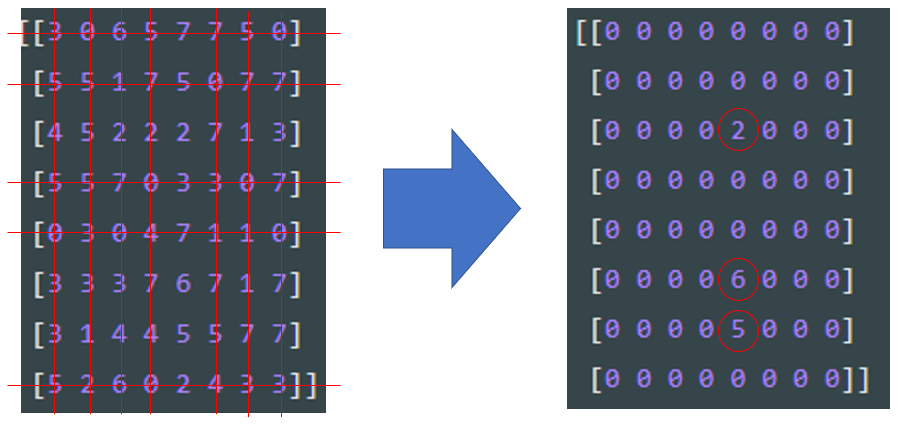

もう少し難易度を上げてみます。取りあえず、ランダムで整数 0 ~ 4 を

無作為に選んで8行8列の行列を作ってみます。test.pyimport numpy as np arr = np.random.randint(0,4,(8,8)) print(arr)実行結果.py[[2 2 3 2 2 3 2 2] [3 1 0 2 1 2 3 1] [3 0 1 3 3 1 2 1] [1 2 1 1 1 2 2 2] [1 2 3 2 3 0 3 0] [0 2 0 0 0 1 0 3] [0 2 3 0 0 2 2 1] [3 3 2 3 3 2 2 0]]取りあえず、ランダムに構成した行列から 0 を探します。

@LouiS0616さんに教わった記述は 1 つだけ見つけるやり方みたいで、

他にやり方があると思うのですが、すいません、上手くいきませんでした m(_ _)m。

取りあえず、正攻法で行きます。test.pyarr_pt=[]# カラのリストを作ります。 for i in range(8): for j in range(8): if arr[i,j] == 0: arr_pt.append([i,j])#カラのリストに、arr[i,j] == 0 となる座標を入れていきます。実行結果.py[[2 0 2 1 1 0 3 3] [3 0 3 3 2 0 2 3] [2 2 0 3 0 2 0 2] [3 0 2 2 2 2 0 2] [3 0 3 0 1 0 1 0] [2 2 1 2 1 0 2 3] [1 3 2 1 2 0 0 1] [3 0 3 2 2 3 3 2]] #以下のリストは見やすくするために、一旦、改行入れました m(_ _)m #尚、座標は 0 行、0 列からのカウントになっています。 [[0, 1], [0, 5], [1, 1], [1, 5], [2, 2], [2, 4], [2, 6], [3, 1], [3, 6], [4, 1], [4, 3], [4, 5], [4, 7], [5, 5], [6, 5], [6, 6], [7, 1]]python のリストは上限が無いので、

ランダムに生成した行列でも 0 の数が異なるのですが、

一通り、座標を格納してくれます、有難う( `ー´)ノ後は、格納したリストから、座標情報を取り出してみます。

今回は0 が見つかった行と列、全てを 0 に編集します。

取りあえず、さらっと載せますが、説明は後でします。test.pyfor k in range(len(arr_pt)): for l in range(8): arr[arr_pt[k][0],l] = 0 for m in range(8): arr[m,arr_pt[k][1]] = 0 print(arr)実行結果.py#before [[3 2 3 2 2 1 2 2] [3 2 3 2 0 3 0 0] [3 3 3 0 2 2 0 1] [1 3 1 1 3 0 0 1] [2 0 1 3 2 0 3 3] [0 1 0 0 1 0 3 1] [2 0 3 0 1 3 2 2] [0 0 3 2 1 3 2 0]] #after [[0 0 0 0 0 0 0 0] [0 0 0 0 0 0 0 0] [0 0 0 0 0 0 0 0] [0 0 0 0 0 0 0 0] [0 0 0 0 0 0 0 0] [0 0 0 0 0 0 0 0] [0 0 0 0 0 0 0 0] [0 0 0 0 0 0 0 0]]全部 0 になっちゃいました(笑)

ちょっとバランスを調整しつつ、

全体像を再掲します。test.pyimport numpy as np arr = np.random.randint(0,8,(8,8))# 8x8 の行列なので、0 - 8 をランダムに選ぶ事にしました。 print(arr) arr_pt=[] for i in range(8): for j in range(8): if arr[i,j] == 0: arr_pt.append([i,j]) print(arr_pt) #arr_pt[0][0] は arr_pt[0] = X としてしまえば、X[0] って事です #これをヒントにしたの記述を読んでみてください for k in range(len(arr_pt)): for l in range(8): arr[arr_pt[k][0],l] = 0 # arr_pt[k] を X とすると arr[X[0],l] になります/特定の行の値を all 0 for m in range(8): arr[m,arr_pt[k][1]] = 0 # arr_pt[k] を X とすると arr[m,X[1]] になります/特定の列の値を all 0 print(arr)実行結果.py#before [[3 0 6 5 7 7 5 0] [5 5 1 7 5 0 7 7] [4 5 2 2 2 7 1 3] [5 5 7 0 3 3 0 7] [0 3 0 4 7 1 1 0] [3 3 3 7 6 7 1 7] [3 1 4 4 5 5 7 7] [5 2 6 0 2 4 3 3]] # 0 address (= arry_pt) [[0, 1], [0, 7], [1, 5], [3, 3], [3, 6], [4, 0], [4, 2], [4, 7], [7, 3]] #after [[0 0 0 0 0 0 0 0] [0 0 0 0 0 0 0 0] [0 0 0 0 2 0 0 0] [0 0 0 0 0 0 0 0] [0 0 0 0 0 0 0 0] [0 0 0 0 6 0 0 0] [0 0 0 0 5 0 0 0] [0 0 0 0 0 0 0 0]]個人的には、0 の座標を見つけてリストに取り込んだ後が悩みました。

例えば以下の実行結果から、例えば arr_pt[0] とすると。。実行結果.py[[0, 1], [0, 7], [1, 5], [3, 3], [3, 6], [4, 0], [4, 2], [4, 7], [7, 3]] # arr_pt [0, 1]# arr_pt[0]っとなります。座標を取り出すのは良いけど、

どうやって、8 x 8 の行列の要素に反映すればいいのか分かりませんでした。

さらっと書いていますが、arr_pt[0][0] とすれば [0,1] から 0 を取り出してくれます。

逆に arr_pt[0][1] とすれば [0,1] から 1 を取り出してくれます。面白いですね。

あとは、ここまで for を使い込まなくても良い気がしますが

すいません、good idea が思い浮かばず。。有識者の方、アドバイスがあれば宜しくお願い致します。m(_ _)m

- 投稿日:2020-10-21T23:11:13+09:00

[翻訳]NumPy公式チュートリアル "NumPy: the absolute basics for beginners"

訳者による紹介

本記事は、NumPy v.1.19 公式Documentation内の "NumPy: the absolute basics for beginners" の翻訳です。このドキュメントが開発版から本リリース扱いに変わったことをきっかけに、公開しました。

近年Pythonの人気は高止まりしています。その理由の一つは、AIブームとPythonの機械学習ライブラリの充実でしょう。Pythonが機械学習など科学技術計算分野でのライブラリが豊富であることが、さらなるライブラリの拡充や、初心者に限らない支持を引き起こしているようです。

NumPyはこれら科学技術計算ライブラリの基盤となるシステムです。NumPyが採用される理由に、Pythonの速度の問題があります。Pythonは言語の特性上、一部の操作は非常に低速であることで知られています。そのため多くのライブラリは、Pythonの速度が処理のボトルネックになることを回避するために、C言語で実装されたNumPyなどを使うことで大量のデータ処理にも耐えうる速度を実現しているのです。

NumPyはとても便利かつ高速に作動する魅力がありますが、Python自身と比べるとすこしとっつきにくいかもしれません。本記事では、NumPyの基礎を、画像をまじえつつ明快に説明していています。解説の範囲は"Quickstart tutorial"の半分以上をカバーしているので、あの無味乾燥なチュートリアルを読まずとも、ある程度のことができるようになるはずです。

また、【初心者向け】図解でわかるNumPyとデータ表現にも目を通すと参考になるかもしれません。執筆者は本記事の画像の作成者です。

誤訳等の指摘をいただけると大変助かります。以下翻訳

NumPy完全初心者へのガイドへようこそ!もしコメントや提案があれば、遠慮なく連絡してください!

Welcome to NumPy!

NumPy (Numerical Python)は科学と工学(engineering)のほとんどすべての領域で用いられているオープンソースPythonライブラリです。Numpyは数値データを扱うための世界標準であり、ScientificPythonとPydata系の中核です[Pydata ecosystems: Numpyの開発元Pydataの製品群]。NUmpyユーザーには始めたてのプログラマーから、最先端の科学・工学研究と開発を行うベテラン研究者までいます。Numpy APIはPandas, SciPy, Matplotlib, scikit-learn, scikit-imageや他のほとんどのデータサイエンス用や科学用Pythonパッケージに広く用いられています。

Numpyライブラリは多次元の配列と行列データ構造を持ちます(これに関しては後の節でより詳しく説明します)。Numpyは、同種[同じデータ型]のn次元の配列オブジェクトであるndarrayを、配列を効率的に処理するためのメソッドと併せて提供します。Numpyは配列についての多様な数学的操作を行うために用いることができます。Numpyは配列と行列の効率的な計算を保証する力強いデータ構造をPythonに付け足し、これら配列と行列で働く高度の数学的機能を持った巨大なライブラリを提供します。

Learn more about NumPy here!NumPyをインストールする

NumPyをインストールするには、科学用Pythonディストリビューションを利用することを強く勧めます。もし

お使いのOSにNumPyをインストールするための完全な手引きが必要なら、ここですべての詳細を見つけることができます。もしすでにPythonを使っているなら、以下のコードでNumPyをインストールできます。

conda install numpyあるいは

pip install numpyもしまだPythonを持っていないのであれば、Anacondaの使用を検討するのがよいでしょう。AnacondaはPythonを一番簡単に始められる方法です。このディストリビューションを使う利点は、NumPyやデータ解析に使われる主要なパッケージ、pandas、Scikit-Learnなどを個々にインストールすることをそこまで心配する必要がないことです。

You can find all of the installation details in the Installation section at SciPy.

NumPyをインポートする方法

パッケージやライブラリを使いたい時はいつでも、最初に使いたいものをアクセス可能にする必要があります。

NumPyとそれに備わるすべての機能を使いはじめるには、NumPyをインポートしなければなりせん。これは次のインポート文[statement]によって簡単にできます。import numpy as np(我々はNumPyをnpと省略します。それは時間を節約するためであり、またコードを標準化しておくことで、そのコードを使って働く誰もが簡単に理解でき実行できるようにするためです。)

コード例の読み方

もしコードがたくさんのチュートリアルを読むのにまだ慣れていないなら、どのように次のようなコードブロックを理解すればよいかわからないかもしれません。

>>> a = np.arange(6) >>> a2 = a[np.newaxis, :] >>> a2.shape (1, 6)もしこのやり方をよく知らなくても、この表記法はとても理解しやすいです。もし>>>があれば、入力、つまりあなたが入力するだろうコードを指しています。コードの前に>>>がないものはすべて出力、つまりコードを実行した結果です。これはPythonをコマンドラインで実行するときのスタイルですが、IPythonを使うときは、異なるスタイルが表示されるかもしれません。

Python list と NumPy arrayの違いは何ですか?

NumPyは、配列を作り数値データを操作するための高速かつ効率的な方法を非常に多く備えています。Pyhonリストは一つのリストに異なったデータ型を持つことが可能ですが、NumPy配列で配列上のすべての要素は同種でなければなりません。もし配列に他のデータ型が混ざっていれば、配列上で働くはずの数学的操作はひどく非効率になるでしょう。

NumPyはなぜ使われているのですか?

NumPy配列はPythonリストよりも高速で簡潔です。[Pythonの]配列はメモリーをあまり使わず、使用するのに便利です。それと比べてもNumPyがデータをためるためにメモリーを使う量ははるかに少なく、データタイプを識別するメカニズムも備えています。このことはコードをさらに最適化することを可能にします。

配列とはなんですか?

配列とはNumPyライブラリの主要なデータ構造のひとつです。配列は値たちのグリッドであり配列は生のデータについての情報、要素をどのように配置するかについての情報、要素をどのように理解(interpret)するかについての情報を持ちます。NumPyが持つ諸要素からなるgridは、様々な方法でインデックスすることができます。要素はすべて同種であり、配列の

dtypeとして表されます。配列は正の整数のタプル、ブール値(booleans)、別の配列や整数によってインデックス可能です。配列の

rankは次元の数です。配列のshapeは各次元に沿った配列のサイズを表す整数のタプルです。

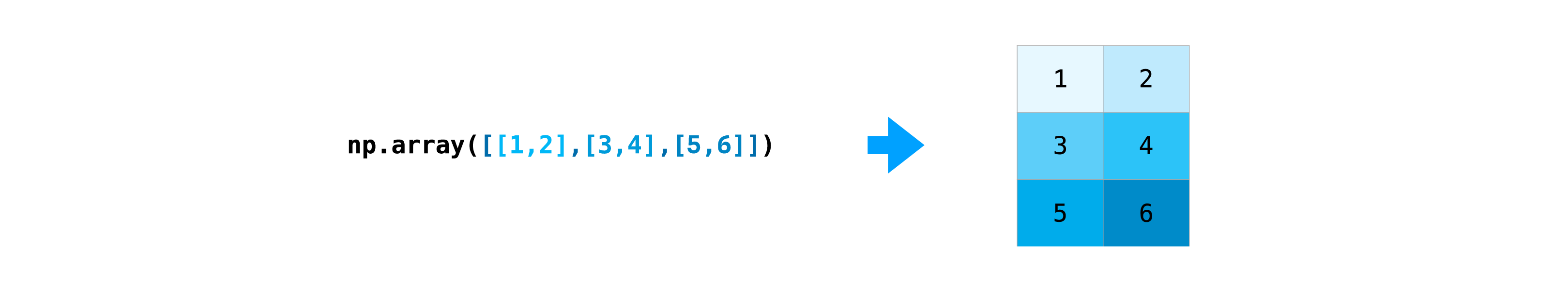

NumPy配列を初期化する一つの方法は、Pythonリストから初期化することです。二次元以上のデータにはネストしたリストを用います。例:

>>> a = np.array([1, 2, 3, 4, 5, 6])あるいは

>>> a = np.array([[1, 2, 3, 4], [5, 6, 7, 8], [9, 10, 11, 12]])配列の要素にアクセスするには鍵括弧を使います。配列の要素にアクセスするとき、NumPyのインデックスは0から始まることを忘れないでください。これはあなたが配列の最初の要素にアクセスしたいならば、配列”0”にアクセスすることになるだろうという意味です。

>>> print(a[0]) [1 2 3 4]配列についてさらに詳しく

この節では

1D array,2D array,ndarray,vector,matrixを扱います「ndarray」と表記される配列を時折目にしたことがあるかもしれません。これは「N次元配列」の略記です。N次元配列は簡単に言うと任意の次元数をもつ配列です。「1-D」ないし一次元配列、「2-D」ないし二次元配列、etc...、もまた目にしたことがあるかもしれません。NumPyのndarrayクラスは行列とベクトルのどちらを表すのにも使われます。ベクトルは一次元配列(行ベクトルと列ベクトルの違いはありません)であり、行列は二次元の配列を参照します。 3D(三次元)以上の配列では、テンソルという用語もよく使われます。

配列の属性とはなんですか?

配列は通常、同じ種類かつ同じサイズの項目の固定サイズのコンテナです。配列の次元数と項目は配列の形から定義されます。配列の形は各次元のサイズを規定する自然数のタプルです。

NumPyでは、次元はaxesと呼ばれます。すなわち、もし次のような配列があるなら[[0., 0., 0.], [1., 1., 1.]]この配列は二つの軸を持ちます。一つ目の軸の長さは2で、二つ目の長さは3です。

他のPythonコンテナと同様に、インデックスやスライシングで配列の内容にアクセスしたり修正したりすることができます。ですが典型的なコンテナオブジェクトと違って、同じデータを異なる配列で共有できるので、ある配列で行われた変更が、別の配列で現れるかもしれません。配列の属性は配列固有の情報を反映します。もし新たに配列を作らずに配列のプロパティを得る、あるいは設定する必要があるなら、配列の属性を通して配列にアクセスすることが多いです。

Read more about array attributes here and learn about array objects here.

簡単な配列をつくる方法

この節では

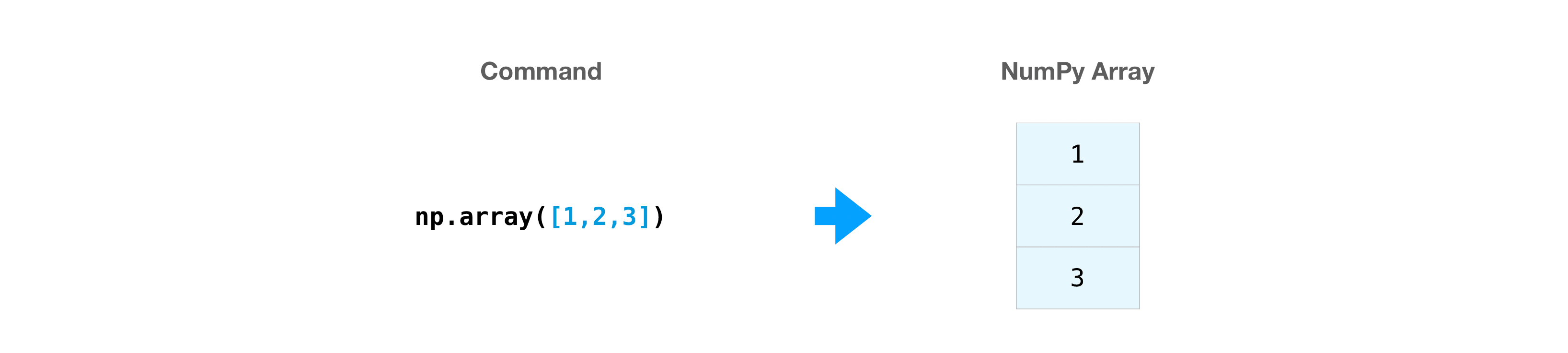

np.array(),np.zeros(),np.ones(),np.empty(),np.arange(),np.linspace(),dtypeを扱いますNumPy配列を作るには、関数

np.array()を使います。

簡単な配列を作るのに必要なことは、リストを渡すことです。必要に応じてリストのデータ型を指定することもできます。 You can find more information about data types here.>>> import numpy as np >>> a = np.array([1, 2, 3])次のように配列を視覚化することができます。

これらの視覚化は概念をわかりやすくし、NumPyの発想と仕組みの基礎的な理解を与えるためのものであることに注意してください。配列と配列操作はここで表現されたものよりはるかに複雑です。

要素の連続から作る配列以外にも、0で埋め尽くされた配列を簡単に作成することができます。>>> np.zeros(2) array([0., 0.])他にも

1で埋め尽くされた配列を作ることができます。>>> np.ones(2) array([1., 1.])あるいは空の配列だってすら!

empty関数は、初期内容がランダムかつメモリの状態に依存する配列を作成します。empty関数をzero関数(やそれに似たもの)に優先して使う理由はスピードです。後ですべての要素を埋めるのを忘れないようにしてください!>>> # Create an empty array with 2 elements >>> np.empty(2) array([ 3.14, 42. ]) # may vary連続した要素の配列を作成できます:

>>> np.arange(4) array([0, 1, 2, 3])そして均等に間隔をあけた列からなる配列も作成できます。そのためには、最初の数・最後の数・ステップ数を指定します。

>>> np.arange(2, 9, 2) array([2, 4, 6, 8])

np.linspace()を使用して、指定した間隔で線形に間を空けた値を持つ配列を作成することができます。>>> np.linspace(0, 10, num=5) array([ 0. , 2.5, 5. , 7.5, 10. ])データタイプを指定する

デフォルトのデータ型は浮動小数点(np.float64)ですが、使いたいデータ型をdtypeキーワードで明示的に指定できます。

>>> x = np.ones(2, dtype=np.int64) >>> x array([1, 1])Learn more about creating arrays here

要素を追加・削除・ソートする

この節は

np.sort(),np.concatenate()を扱います要素をソートするとき、

np.sort()を使うと簡単です。この関数を呼ぶ際には、軸、種類、順序を指定できます。この配列を例にとると、

>>> arr = np.array([2, 1, 5, 3, 7, 4, 6, 8])こうして昇順に素早く並び替えることができます。

>>> np.sort(arr) array([1, 2, 3, 4, 5, 6, 7, 8])sortは配列にソートされたコピーをかえしますが、その外にも以下を利用できます

・argsort: 指定された軸による間接ソート

・lexsort: 複数のキーによる間接的な静的ソート[indirect stable sort on multiple keys]

・searchsorted: ソートされた配列から要素を発見する

・partition: 部分ソートこれらの配列を例にしましょう:

>>> a = np.array([1, 2, 3, 4]) >>> b = np.array([5, 6, 7, 8])np.concatenate()でこれらの配列を連結することができます。

>>> np.concatenate((a, b)) array([1, 2, 3, 4, 5, 6, 7, 8])また、この配列を例にとると、:

>>> x = np.array([[1, 2], [3, 4]]) >>> y = np.array([[5, 6]])こうすることで連結できます:

>>> np.concatenate((x, y), axis=0) array([[1, 2], [3, 4], [5, 6]])配列から要素を削除するには、インデックスを使用して残したい要素を選択するのが簡単です。

連結についてさらに知りたい場合は、右を参照してください:concatenate.配列の形とサイズをどうやって知るか?

このセクションは

ndarray.ndim,ndarray.size,ndarray.shapeを扱います

ndarray.ndimは配列の軸の数、すなわち次元の数を示します。

ndarray.sizeは配列の要素の総数を示します。これは配列のサイズの要素を掛けたものです。

ndarray.shapeは配列の次元ごとに格納されている要素の数を示す整数のタプルを表示します。たとえば、2行3列の2次元配列がある場合、配列の形状は(2,3)です。たとえば、次の配列を作成するとします。

>>> array_example = np.array([[[0, 1, 2, 3], ... [4, 5, 6, 7]], ... [[0, 1, 2, 3], ... [4, 5, 6, 7]], ... [[0 ,1 ,2, 3], ... [4, 5, 6, 7]]])配列の次元数を調べるには、次を実行します:

>>> array_example.ndim 3配列の要素の総数を調べるには、次を実行します:

>>> array_example.size 24そして配列の形状を調べるには、次を実行します:

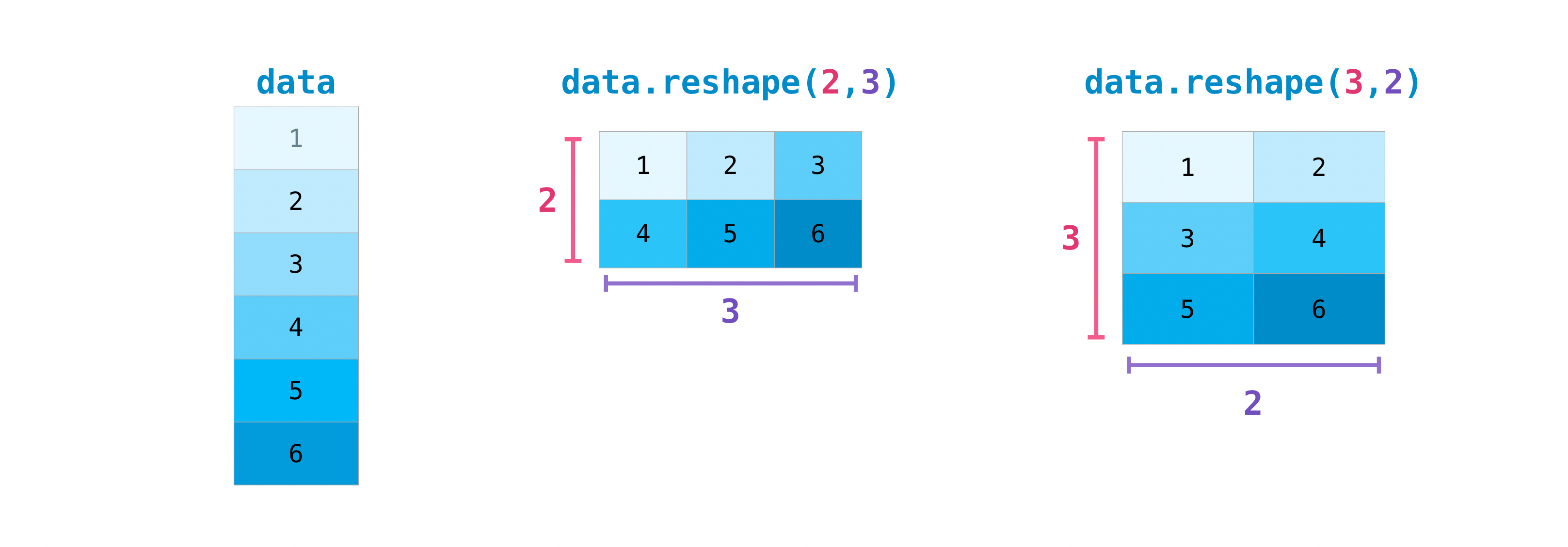

>>> array_example.shape (3, 2, 4)配列を変形できますか?

この節では

arr.reshape()を扱いますもちろん!

arr.reshape()を使えば、データを変更せずに配列に新しい形を与えることができます。この変形メソッドを使うときは、作りたい配列は元の配列と同じ要素数の必要があることを忘れないでください。12個の要素の配列を変形するなら、新たな配列もまた合計で12個の要素を持つことを確かめる必要があります。

この配列を用いるなら:>>> a = np.arange(6) >>> print(a) [0 1 2 3 4 5]配列を変形するために

reshape()を使えます。たとえば、この配列を3行2列の配列に変形することができます:>>> b = a.reshape(3, 2) >>> print(b) [[0 1] [2 3] [4 5]]

np.shape()とともに、いくつかのパラメーターを指定することが可能です。:>>> numpy.reshape(a, newshape=(1, 6), order='C')] array([[0, 1, 2, 3, 4, 5]])

aは形状を変更する配列です。

newshapeは新しい配列の形です。整数か整数のタプルを指定することができます。整数を指定した場合、その整数の長さの配列が生まれます。形状は元の形状と互換性をもつ必要があります。

order:CはCに似たインデックス順序で読み書きすることを表し、FはFortranに似たインデックス順序で読み書きすることを表します。Aは要素がメモリ上でFortran連続であれば、Fortranに似たインデックス順序を使い、そうでなければCに似たインデックスを使うことを意味します(これは任意のパラメーターであり、必ず指定する必要はありません)。

If you want to learn more about C and Fortran order, you can read more about the internal organization of NumPy arrays here. Essentially, C and Fortran orders have to do with how indices correspond to the order the array is stored in memory. In Fortran, when moving through the elements of a two-dimensional array as it is stored in memory, the first index is the most rapidly varying index. As the first index moves to the next row as it changes, the matrix is stored one column at a time. This is why Fortran is thought of as a Column-major language. In C on the other hand, the last index changes the most rapidly. The matrix is stored by rows, making it a Row-major language. What you do for C or Fortran depends on whether it’s more important to preserve the indexing convention or not reorder the data.

Learn more about shape manipulation here.1D配列を2D配列に変換する方法(配列に新しいaxisを加える方法)

この節では

np.newaxis,np.expand_dimsを扱います

np.newaxisとnp.expand_dimsを使えば、既存の配列の次元を増やすことが可能です。

np.newaxisを使用すると、一度だけ使用した場合には、配列の次元が一次元増加します。つまり、1D配列は2D配列に、2D配列は3D配列に、となります。例えば、次の配列では、

>>> a = np.array([1, 2, 3, 4, 5, 6]) >>> a.shape (6,)

np.newaxisを使って新たな軸を追加できます。:>>> a2 = a[np.newaxis, :] >>> a2.shape (1, 6)

np.newaxisを使うことで、行ベクトルか列ベクトルのどちからの1D配列を明示的に変形することができます。たとえば、第1次元上の軸を挿入することで、1D配列を行ベクトルに変換することができます。>>> row_vector = a[np.newaxis, :] >>> row_vector.shape (1, 6)また、列ベクトルには、第2次元上の軸を挿入できます:

>>> col_vector = a[:, np.newaxis] >>> col_vector.shape (6, 1)np.expand_dims で指定した軸を挿入して、配列を拡張することも可能です。

たとえば、この配列では、:>>> a = np.array([1, 2, 3, 4, 5, 6]) >>> a.shape (6,)インデックス位置1に軸を追加するには

np.expand_dimsを使用できます。:>>> b = np.expand_dims(a, axis=1) >>> b.shape (6, 1)インデックス位置0に軸を追加するためには次のようにします。:

>>> c = np.expand_dims(a, axis=0) >>> c.shape (1, 6)添え字アクセスとスライス(Indexing and slicing)

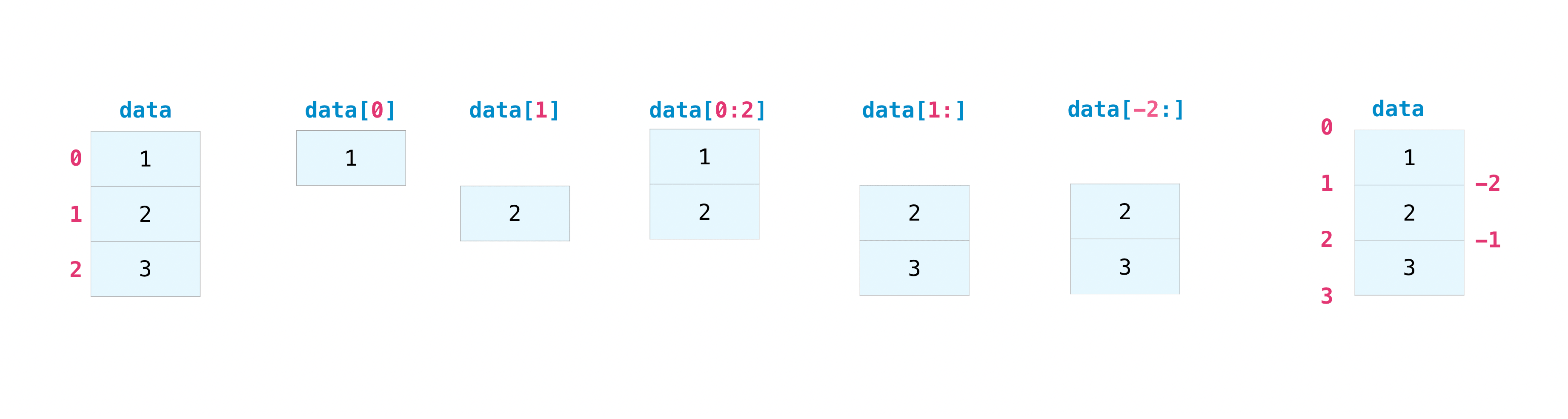

Numpy配列の添え字アクセスとスライスはPythonリストをスライスするのと同じ方法で行えます。

>>> data = np.array([1, 2, 3]) >>> data[1] 2 >>> data[0:2] array([1, 2]) >>> data[1:] array([2, 3]) >>> data[-2:] array([2, 3])さらなる分析や操作に使うために、配列の一部や配列の特定の要素を取り出す必要があるかもしれません。そのためには、配列をサブセット、スライス、そして/もしくは インデクスしなければならないでしょう。

配列から特定の条件を満たす値を抜き出したいなら、NumPyを使うと簡単です。

たとえば、次の配列を例にします。

>>> a = np.array([[1 , 2, 3, 4], [5, 6, 7, 8], [9, 10, 11, 12]])配列にある5未満の数値を簡単に表示できます.

>>> print(a[a < 5]) [1 2 3 4]また、例えば5以上の数値を選択して、その条件を用いて配列のインデックスを作成することもできます。

>>> five_up = (a >= 5) >>> print(a[five_up]) [ 5 6 7 8 9 10 11 12]2で割れる要素たちを取り出すこともできます。:

>>> divisible_by_2 = a[a%2==0] >>> print(divisible_by_2) [ 2 4 6 8 10 12]

&と|演算子を使い、二つの条件を満たす要素をとりだすこともできます:>>> c = a[(a > 2) & (a < 11)] >>> print(c) [ 3 4 5 6 7 8 9 10]また、論理演算子& と | を使って、配列の値がある条件を満たすか否かを示すブール値を返すこともできます。これは名前や別カテゴリーの値を持つ配列のときに便利です。

>>> five_up = (a > 5) | (a == 5) >>> print(five_up) [[False False False False] [ True True True True] [ True True True True]]

np.nonzero()を使い配列から要素の要素やインデクスを選択することも可能です。

次の配列を起点にしましょう:>>> a = np.array([[1, 2, 3, 4], [5, 6, 7, 8], [9, 10, 11, 12]])

np.nonzero()を使って、この場合では5未満の、要素のインデクスを表示することができます:>>> b = np.nonzero(a < 5) >>> print(b) (array([0, 0, 0, 0]), array([0, 1, 2, 3]))この例では配列のタプルが返されます。返されるタプルはそれぞれの次元に一つずつです。第一の配列は条件を満たす値がある行インデクスを表し、第二の配列は条件を満たす値がある列インデクスを示します。

要素がある座標のリストを生成したい場合、この配列をzipし、座標のリストを反復処理して、表示することができます。たとえば、:

>>> list_of_coordinates= list(zip(b[0], b[1])) >>> for coord in list_of_coordinates: ... print(coord) (0, 0) (0, 1) (0, 2) (0, 3)np.nonzero()を使って配列中で5未満の要素を表示することもまたできます:

>>> print(a[b]) [1 2 3 4] ```shell 探している要素が配列に存在しない場合、戻り値のインデクスの配列は空になります。たとえば、以下のようになります。 ```shell >>> not_there = np.nonzero(a == 42) >>> print(not_there) (array([], dtype=int64), array([], dtype=int64))既存のデータから配列をつくる方法

この節では

slicing and indexing,np.vstack(),np.hstack(),np.hsplit(),.view(),copy()を扱います既存の配列の部分からたやすく配列を作ることができます。

次の配列があるとしましょう。>>> a = np.array([1, 2, 3, 4, 5, 6, 7, 8, 9, 10])配列のスライスしたい部分を指定することで、配列の部分からいつでも新しい配列を作ることができます。

>>> arr1 = a[3:8] >>> arr1 array([4, 5, 6, 7, 8])ここで、インデクス位置3からインデクス位置8までの範囲を指定しています。

既存の配列二つを連結するのは縦横どちらにもできます。次の二つの配列、

a1,a2があるとします。>>> a1 = np.array([[1, 1], ... [2, 2]]) >>> a2 = np.array([[3, 3], ... [4, 4]])

vstackを使って、これらを縦に積み重ねることができます。>>> np.vstack((a1, a2)) array([[1, 1], [2, 2], [3, 3], [4, 4]])そして

hstackで横に積み重ねることができます。>>> np.hstack((a1, a2)) array([[1, 1, 3, 3], [2, 2, 4, 4]])

hsplitで配列をいくつかの小さな配列に分割することができます。配列を同形配列何個に分割するかや、分割後の列の数を指定することができます。この配列があるとしましょう:

>>> x = np.arange(1, 25).reshape(2, 12) >>> x array([[ 1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12], [13, 14, 15, 16, 17, 18, 19, 20, 21, 22, 23, 24]])もしあなたがこの配列を3つの同じ形の配列へと分割したいなら、次のコードを実行しましょう。

>>> np.hsplit(x, 3) [array([[1, 2, 3, 4], [13, 14, 15, 16]]), array([[ 5, 6, 7, 8], [17, 18, 19, 20]]), array([[ 9, 10, 11, 12], [21, 22, 23, 24]])]もし3列目と4列目の後ろで配列を分割したいなら、次のコードを実行しましょう。

>>> np.hsplit(x, (3, 4)) [array([[1, 2, 3], [13, 14, 15]]), array([[ 4], [16]]), array([[ 5, 6, 7, 8, 9, 10, 11, 12], [17, 18, 19, 20, 21, 22, 23, 24]])]Learn more about stacking and splitting arrays here.

viewメソッドを使って、元の配列と同じデータを参照する新たな配列を作ることができます(浅いコピー:shallow copy)。ビューはNumPyの重要な概念の一つです。NumPyの関数は、添字アクセスやスライスなどの操作と同様に、可能な限りビューを返します。これはメモリの節約になり、高速です(データのコピーを作成する必要がありません)。しかし注意しなければならないことがあります––ビュー内のデータを変更すると、元の配列も変更されてしまいます。

次のような配列を作成したとしましょう。

>>> a = np.array([[1, 2, 3, 4], [5, 6, 7, 8], [9, 10, 11, 12]])ここで

aをスライスしてb1をつくり、b1の最初の要素を変更します。この操作はaの対応する要素をも変更します。>>> b1 = a[0, :] >>> b1 array([1, 2, 3, 4]) >>> b1[0] = 99 >>> b1 array([99, 2, 3, 4]) >>> a array([[99, 2, 3, 4], [ 5, 6, 7, 8], [ 9, 10, 11, 12]])

copyメソッドを使用すると、配列とそのデータの完全なコピーを作成します(ディープコピー)。これを配列に使用するには、次のコードを実行します。>>> b2 = a.copy()配列の基本的演算(operation)

この節では加算、減算、乗算、除算などを扱います

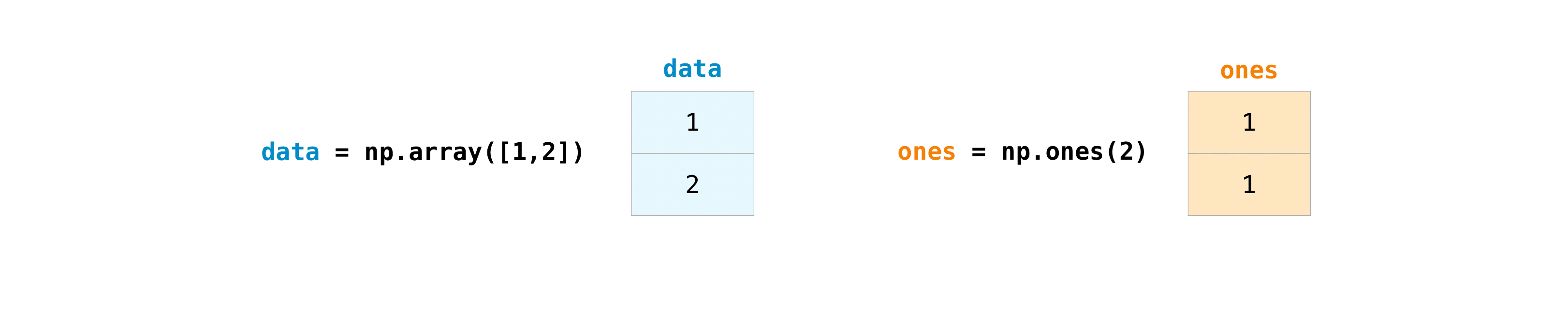

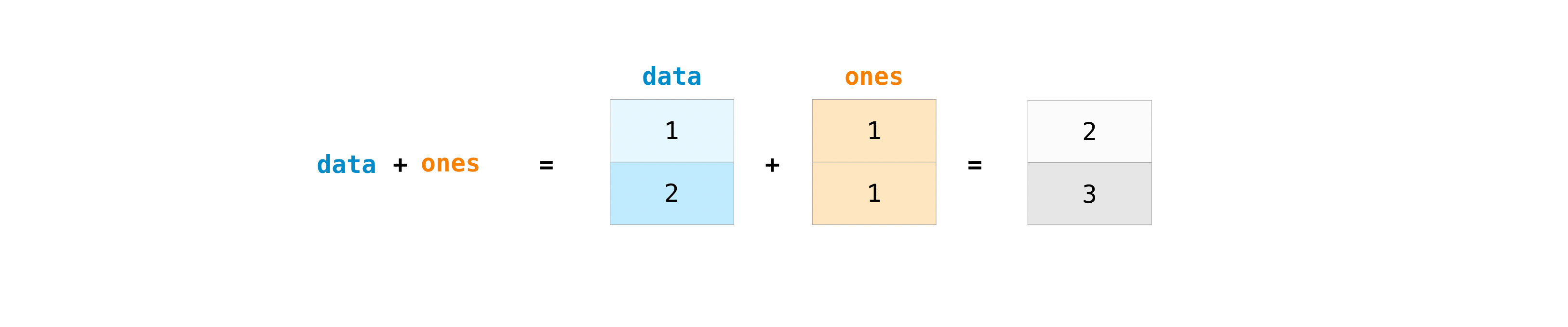

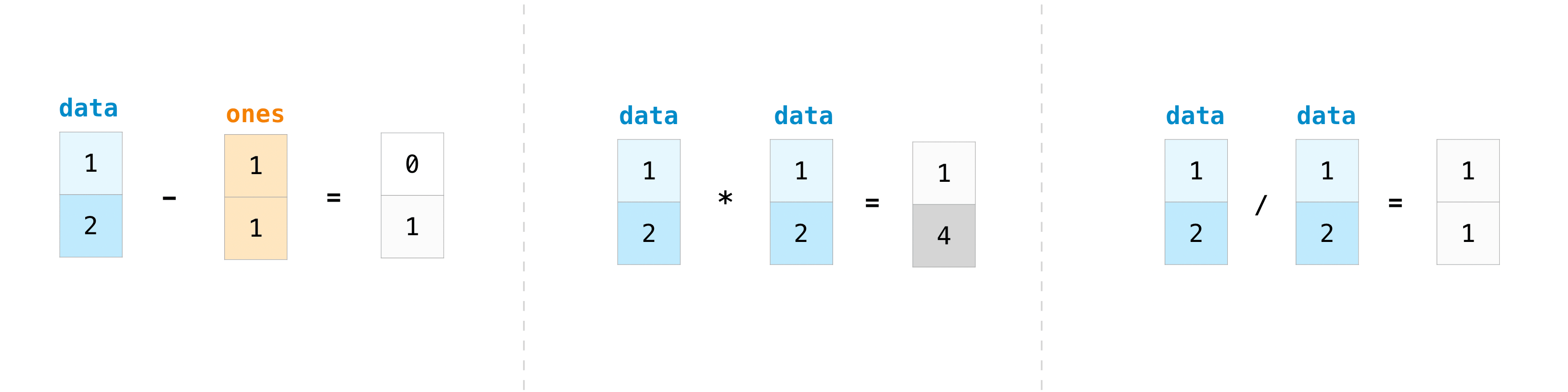

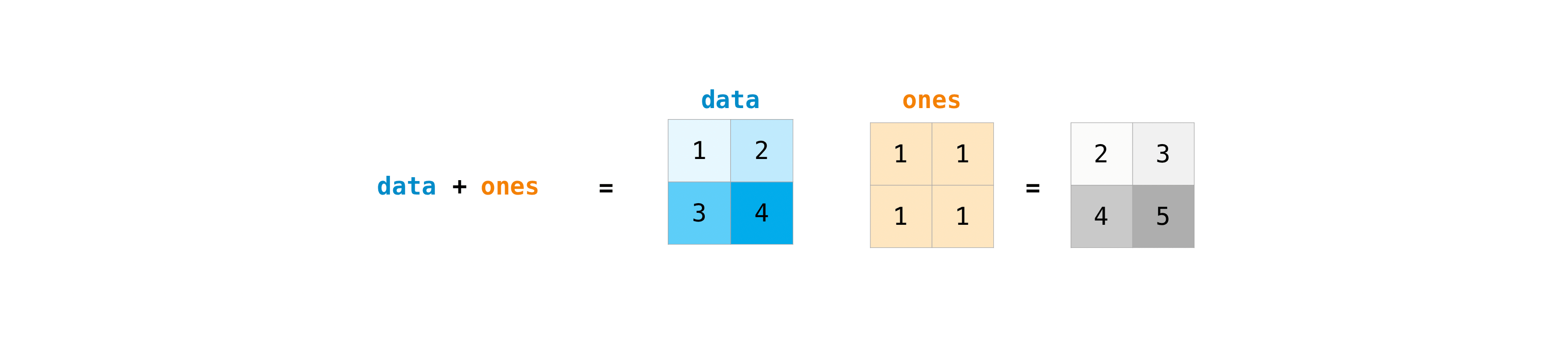

配列を作成したら、その配列で作業を始めることができます。例えば、”data”と”ones”と呼ばれる二つの配列を作成したとしましょう。

プラス記号を使って配列を足し合わせることができます。

>>> data = np.array([1, 2]) >>> ones = np.ones(2, dtype=int) >>> data + ones array([2, 3])もちろん、できることは加算だけに留まりません!

>>> data - ones array([0, 1]) >>> data * data array([1, 4]) >>> data / data array([1., 1.])NumPyでは基本的操作は簡単です。もし配列の合計を知りたいなら、sum()を使いましょう。これは1D, 2Dやそれ以上の配列で動きます。

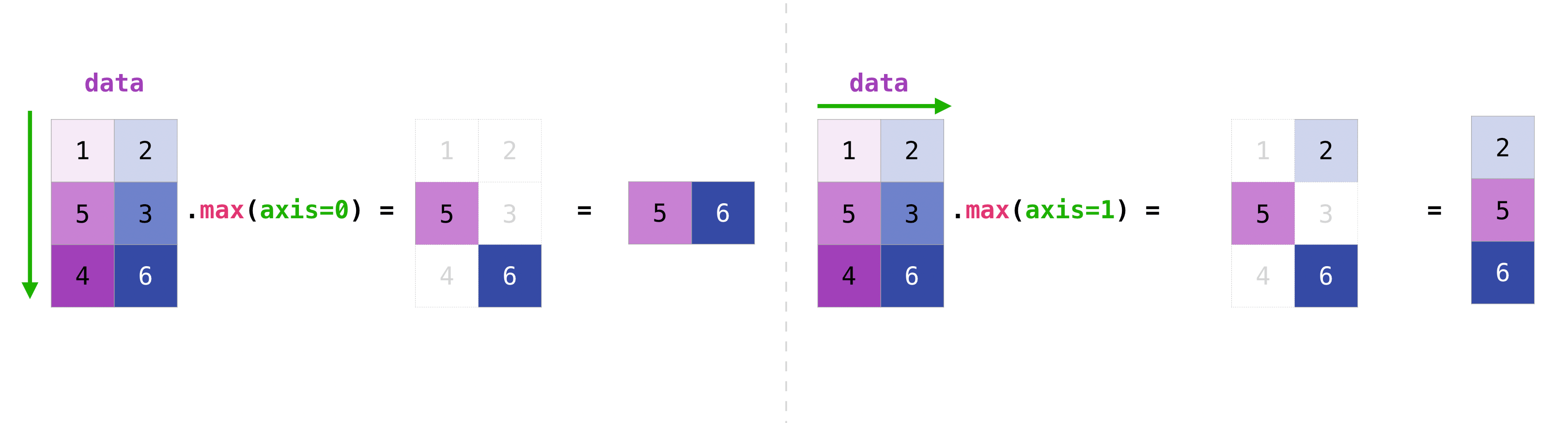

>>> a = np.array([1, 2, 3, 4]) >>> a.sum() 10二次元配列で列や行を加算したいなら(To add the rows or the columns in a 2D array)、軸を指定します。

この配列から始める場合、:>>> b = np.array([[1, 1], [2, 2]])行は次のように合計できます:

>>> b.sum(axis=0) array([3, 3])列は次のように合計できます。:

>>> b.sum(axis=1) array([2, 4])Broadcasting

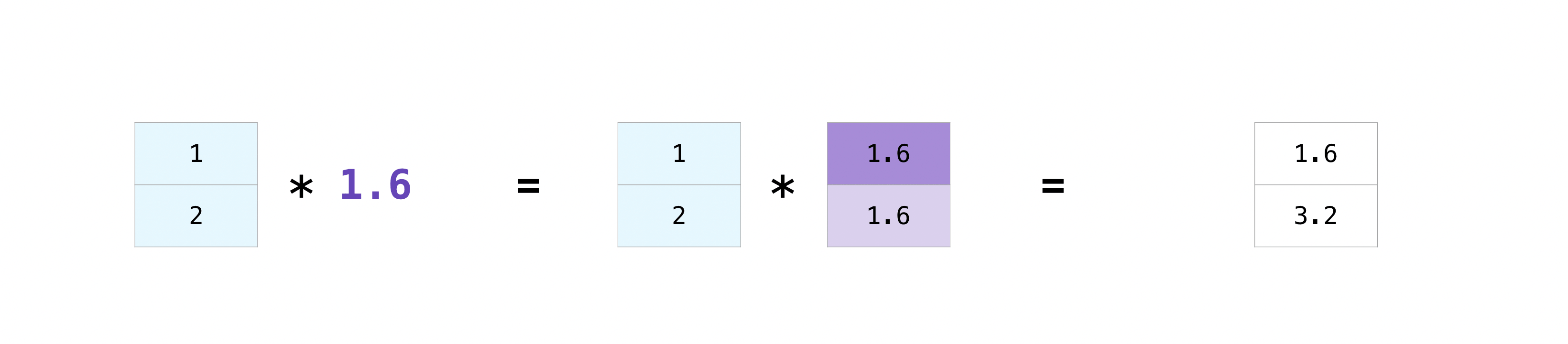

配列とひとつの数とで、あるいは異なるサイズの配列間で、演算したい時があります(前者はベクトルとスカラー間の演算とも呼ばれます)。たとえば、ある配列(”data”と呼びます)は何マイル離れているかの情報を持っており、あなたはそれをキロメートルに変換したいものとします。この操作を次のように行うことができます。

>>> data = np.array([1.0, 2.0]) >>> data * 1.6 array([1.6, 3.2])NumPyは掛け算が一つ一つのセルで行われなければならないことを了解しています。このコンセプトはブロードキャストと呼ばれます。ブロードキャステトはNumPyが相異なる形の配列の演算を行うための仕組みです。配列の次元は互換性がなければなりません。例えば、両方の配列の次元が同じか、片方が1次元の場合にそうです。もしそうでなければ、

ValueErrorが発生します。より便利な配列操作

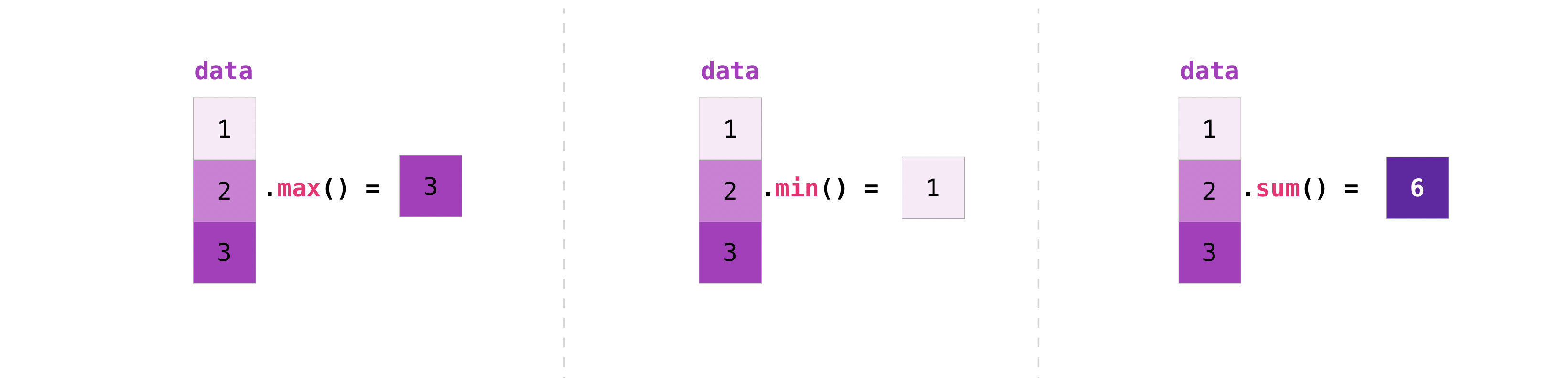

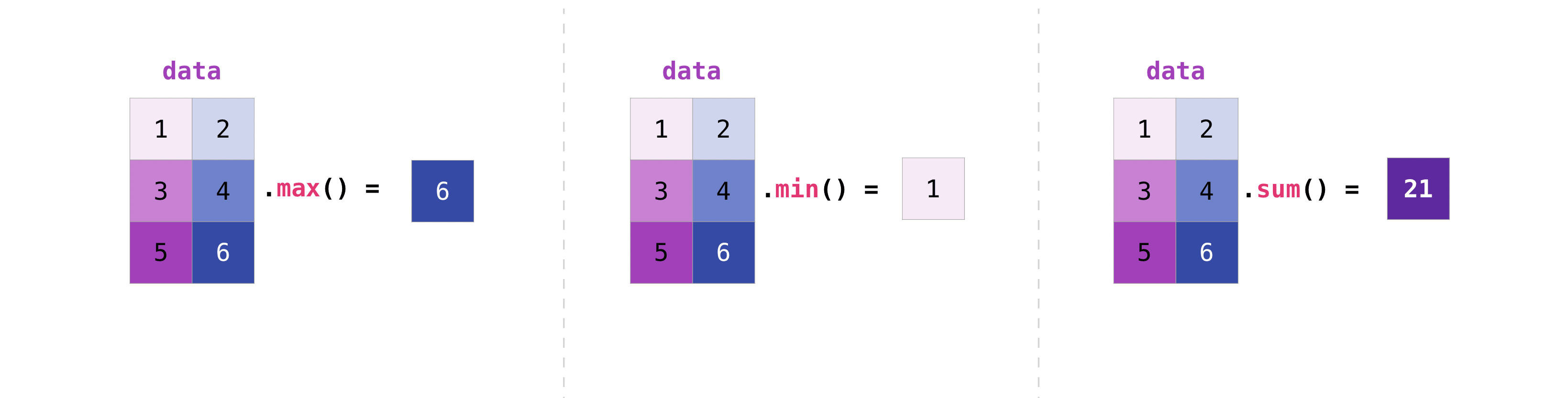

This section covers maximum, minimum, sum, mean, product, standard deviation, and moreNumPyは集合関数も実行する。

min,max,sumに加えて、平均を得るためのmean, 要素をかけ合わせた結果を得るためのprod, 標準偏差を得るためのstdなどを簡単に実行できます。>>> data.max() 2.0 >>> data.min() 1.0 >>> data.sum() 3.0まずこの配列、“a”から始めましょう

>>> a = np.array([[0.45053314, 0.17296777, 0.34376245, 0.5510652], ... [0.54627315, 0.05093587, 0.40067661, 0.55645993], ... [0.12697628, 0.82485143, 0.26590556, 0.56917101]])行や列に沿って集計したいというのは非常によくあることです。デフォルトでは、NumPy集計関数はすべて、配列全体の総和を返します。配列の要素の合計や最小値を知りたいときは、次のコードを用います。

>>> a.sum() 4.8595784あるいは:

>>> a.min() 0.05093587どの軸で集計関数をさせたいのか指定することができます。たとえば、axis=0とすることで、各列内の最小値を見つけることができます。

>>> a.min(axis=0) array([0.12697628, 0.05093587, 0.26590556, 0.5510652 ])上記の4つの数値は元の配列の行の数値と一致しています。4行の配列では、結果として、4つの値を得ることができます。

行列を作る

Pythonリストを渡して、NumPyでその配列を表す2D配列(または「行列」)を作ることができます。

>>> data = np.array([[1, 2], [3, 4]]) >>> data array([[1, 2], [3, 4]])添え字アクセスとスライス操作は、行列を扱う際に便利です。

>>> data[0, 1] 2 >>> data[1:3] array([[3, 4]]) >>> data[0:2, 0] array([1, 3])行列の操作はベクトルの操作と同じ方法でできます。

>>> data.max() 4 >>> data.min() 1 >>> data.sum() 10行列内のすべての値を集計することも、軸パラメータを使って列か行をまたいで[across columns or rows]集計することができます。

>>> data.max(axis=0) array([3, 4]) >>> data.max(axis=1) array([2, 4])行列を作成したら、同じサイズの行列が二つあれば、算術演算子を使って足し算や掛け算を行えます。

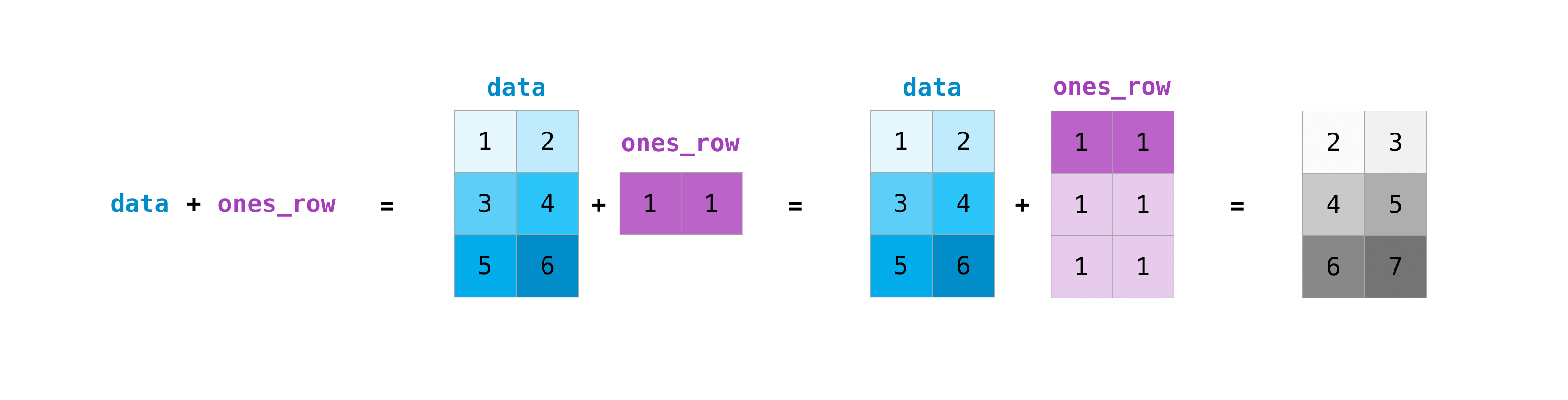

>>> data = np.array([[1, 2], [3, 4]]) >>> ones = np.array([[1, 1], [1, 1]]) >>> data + ones array([[2, 3], [4, 5]])異なるサイズの行列に対してもこれらの算術演算をすることができますが、一方の行列が一行か一列しかない場合に限ります。この場合、NumPyは演算のためにブロードキャスト規則を使います。

>>> data = np.array([[1, 2], [3, 4], [5, 6]]) >>> ones_row = np.array([[1, 1]]) >>> data + ones_row array([[2, 3], [4, 5], [6, 7]])NumPyがN次元の配列を表示するとき、最後の軸は最もループし、対して最初の軸は緩やかにループすることに注意してください[次の例では最後の軸である列に関しては12回のループが、最初の軸については4回のループがある]。

たとえば、>>> np.ones((4, 3, 2)) array([[[1., 1.], [1., 1.], [1., 1.]], [[1., 1.], [1., 1.], [1., 1.]], [[1., 1.], [1., 1.], [1., 1.]], [[1., 1.], [1., 1.], [1., 1.]]])NumPyで配列を初期化したい場合がよくあります。NumPyは

ones()やzeros()といった関数や、乱数生成のためのrandom.Generatorクラスを提供しています。初期化に必要なのは、ただ生成してほしい要素数を渡すことだけです。>>>np.ones(3) array([1., 1., 1.]) >>> np.zeros(3) array([0., 0., 0.]) # the simplest way to generate random numbers >>> rng = np.random.default_rng(0) >>> rng.random(3) array([0.63696169, 0.26978671, 0.04097352])

この関数やメソッドに二次元の行列を表すタプルを与えれば、

ones()、zeros()とrandom()を使って二次元配列も生成可能です。>>> np.ones((3, 2)) array([[1., 1.], [1., 1.], [1., 1.]]) >>> np.zeros((3, 2)) array([[0., 0.], [0., 0.], [0., 0.]]) >>> rng.random((3, 2)) array([[0.01652764, 0.81327024], [0.91275558, 0.60663578], [0.72949656, 0.54362499]]) # may vary乱数を生成する

乱数生成の使用は多くの数学的あるいは機械学習アルゴリズムの配置や評価の重要なパートです。人工神経ネットワークの重さのランダムな初期化、ランダムなセットへの分割、あるいはデータセットのランダムシャッフル、どれにせよ、乱数(実際には、再現可能な擬似乱数の数)の生成をできることは欠かせません。

Generator.integersを使って、最小値から最大値までのランダムな整数を出力できます(Numpyでは最小値は含まれ、最大値は含まれない事に注意してください)。endpoint=Trueを設定して、最高値を含む乱数を生成することができます。0から4までのランダムな整数から成る2×4行列を生成することができます:

>>> rng.integers(5, size=(2, 4)) array([[2, 1, 1, 0], [0, 0, 0, 4]]) # may vary重複しない要素を取り出し数える方法

この節では

np.unique()を扱います

Np.uniqueで配列の要素を重複なしに一つずつ取り出すことができます。

たとえば、この配列を例にします。>>> a = np.array([11, 11, 12, 13, 14, 15, 16, 17, 12, 13, 11, 14, 18, 19, 20])

Np.uniqueを使って配列中のユニークな値を知ることができます。>>> >>> unique_values = np.unique(a) >>> print(unique_values) [11 12 13 14 15 16 17 18 19 20]Numpy配列のユニークな値のインデクス(配列のユニークな値それぞれの最初のインデックス)を得るためには、

np.unique()に配列とともにreturn_index引数を渡してください。>>> unique_values, indices_list = np.unique(a, return_index=True) >>> print(indices_list) [ 0 2 3 4 5 6 7 12 13 14]Numpy配列のユニークな値がそれぞれいくつあるかをしるために、

np.unique()に配列とともにreturn_counts引数をわたすことができます。>>> unique_values, occurrence_count = np.unique(a, return_counts=True) >>> print(occurrence_count) [3 2 2 2 1 1 1 1 1 1]これは二次元配列でも作用します! この配列を用いた場合、

>>> a_2d = np.array([[1, 2, 3, 4], [5, 6, 7, 8], [9, 10, 11, 12], [1, 2, 3, 4]])こうしてユニークな値を見つけることができます。

>>> unique_values = np.unique(a_2d) >>> print(unique_values) [ 1 2 3 4 5 6 7 8 9 10 11 12]軸引数が渡されなかった場合、二次元配列は一次元に平坦化されます。

もしユニークな行や列を知りたい場合、必ずaxis引数をわたすようにしてください。ユニークな行をしるためにはaxis=0を指定し、列にはaxis=1を指定してください。>>> unique_rows = np.unique(a_2d, axis=0) >>> print(unique_rows) [[ 1 2 3 4] [ 5 6 7 8] [ 9 10 11 12]]ユニークな列やインデックス位置や出現数を得るためには、以下のようにします:

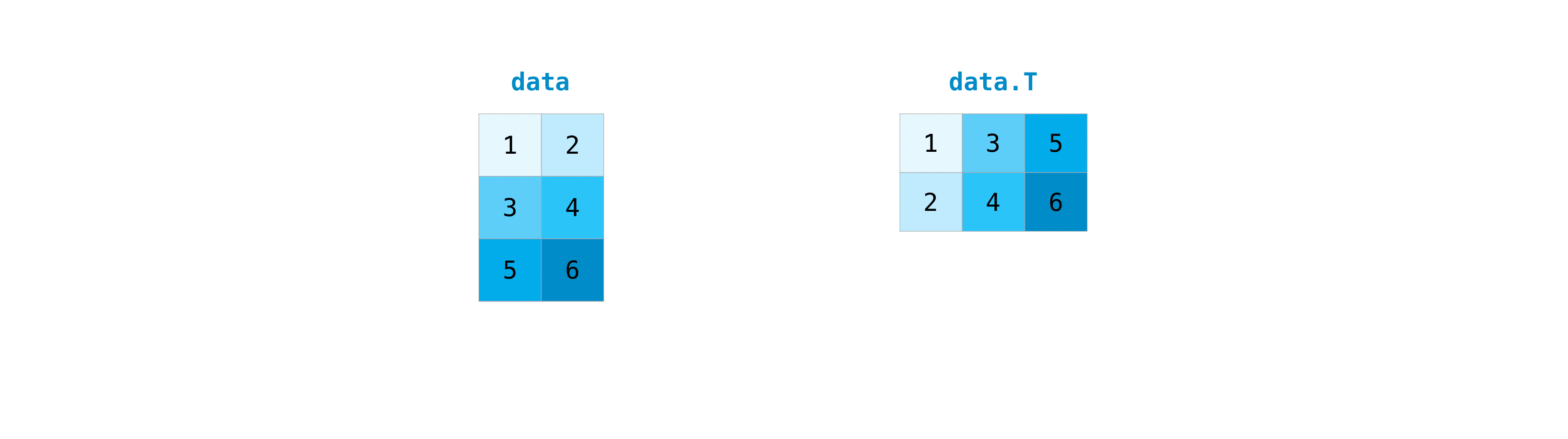

>>> unique_rows, indices, occurrence_count = np.unique( ... a_2d, axis=0, return_counts=True, return_index=True) >>> print(unique_rows) [[ 1 2 3 4] [ 5 6 7 8] [ 9 10 11 12]] >>> print(indices) [0 1 2] >>> print(occurrence_count) [2 1 1]行列の転置と変形

この節では

arr.reshape(),arr.transpose(),arr.T()を扱います

行列の転置を必要とすることはしばしばあります。Numpy配列は行列を転置させるプロパティTを持ちます。また、配列の次元を入れ替える必要があるかもしれません。これはたとえば、データセットと異なる入力の配列形を想定したモデルがある場合などに起こります。このような場合にreshapeメソッドが役に立ちます。必要なのは、行列に必要な新しい寸法[dimensions]を渡すだけです。

>>> data.reshape(2, 3) array([[1, 2, 3], [4, 5, 6]]) >>> data.reshape(3, 2) array([[1, 2], [3, 4], [5, 6]])

.transposeを使って、指定した値に従い、配列の軸を反転させたり変更したりすることもできます。この配列を例にとりましょう:

>>> arr = np.arange(6).reshape((2, 3)) >>> arr array([[0, 1, 2], [3, 4, 5]])

arr.transpose()を使って配列を転置できます。>>> arr.transpose() array([[0, 3], [1, 4], [2, 5]])配列を反転させる方法

この節は

np.flipを扱いますNumPyの

np.flip()はaxisを基準に、配列の軸を反転させることができます。np.flip()を使うときは反転させたい配列と軸を指定してください。軸を指定しない場合、NumPyは与えられた配列をすべての軸に関して反転させます。1D配列を反転させる

次のような一次元配列を例にとりましょう:

>>> arr = np.array([1, 2, 3, 4, 5, 6, 7, 8])こうやって配列を反転できます:

>>> reversed_arr = np.flip(arr)反転された配列を表示したいなら、このコードを実行しましょう:

>>> print('Reversed Array: ', reversed_arr) Reversed Array: [8 7 6 5 4 3 2 1]2D配列を反転させる

2D配列も、ほぼ同じやり方で反転します。

この配列を例にとりましょう:

>>> arr_2d = np.array([[1, 2, 3, 4], [5, 6, 7, 8], [9, 10, 11, 12]])すべての列と行で内容を反転させることができます。

>>> reversed_arr = np.flip(arr_2d) >>> print(reversed_arr) [[12 11 10 9] [ 8 7 6 5] [ 4 3 2 1]]行だけを反転するのはこうするだけです:

>>> reversed_arr_rows = np.flip(arr_2d, axis=0) >>> print(reversed_arr_rows) [[ 9 10 11 12] [ 5 6 7 8] [ 1 2 3 4]]列だけを反転するには:

>>> reversed_arr_columns = np.flip(arr_2d, axis=1) >>> print(reversed_arr_columns) [[ 4 3 2 1] [ 8 7 6 5] [12 11 10 9]]一つの行や列だけを反転させることもできます。たとえば、インデックスが1の行(2行目)を反転させることできます:

>>> arr_2d[1] = np.flip(arr_2d[1]) >>> print(arr_2d) [[ 1 2 3 4] [ 8 7 6 5] [ 9 10 11 12]]インデックスが1の列(2列目)を反転させることもできます:

>>> arr_2d[:,1] = np.flip(arr_2d[:,1]) >>> print(arr_2d) [[ 1 10 3 4] [ 8 7 6 5] [ 9 2 11 12]]多次元配列を再整形・平坦化させる方法

この節では

.flatten(),ravel()を扱います配列をフラットにする一般的な方法は二つあります。

.flatten()と.ravel()です。この二つの主要な違いは、.ravel()を使って作られた配列は、実は親配列への参照(つまり「ビュー」)なのです。したがって、新しい配列を何か変更すると、親配列もまた同様に変更されるということになります。ravelはコピーを作らないので、メモリ効率が良いです。>>> x = np.array([[1 , 2, 3, 4], [5, 6, 7, 8], [9, 10, 11, 12]])You can use flatten to flatten your array into a 1D array.

flattenを使って、配列を1D配列にすることができます。>>> x.flatten() array([ 1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12])When you use flatten, changes to your new array won’t change the parent array.

For example:

flatten‘を使うと、配列への変更は親配列に適用されません。たとえば:

>>> a1 = x.flatten() >>> a1[0] = 99 >>> print(x) # Original array [[ 1 2 3 4] [ 5 6 7 8] [ 9 10 11 12]] >>> print(a1) # New array [99 2 3 4 5 6 7 8 9 10 11 12]But when you use ravel, the changes you make to the new array will affect the parent array.

For example:しかし

ravelを使うと、配列への変更は親配列に適用されません。>>> a2 = x.ravel() >>> a2[0] = 98 >>> print(x) # Original array [[98 2 3 4] [ 5 6 7 8] [ 9 10 11 12]] >>> print(a2) # New array [98 2 3 4 5 6 7 8 9 10 11 12]docstringにアクセスして詳細を知る

この節では

help(),?,??を扱います。データサイエンスエコシステムに関しては[when it comes to]、PythonとNumPyはユーザーのことを念頭に置いて作られています。このことの良い例の一つが、ドキュメンテーションへのアクセスが備え付けられていることです。すべてのオブジェクトは文字列への参照があり、その文字列はdocstringとして知ら得ています。たいていの場合、このdocstringは手短かつ簡潔なオブジェクトの概要と使い方を含みます。Pythonは組み込みのhelp関数を持ち、これはdocstringにアクセスするのを手助けします。つまり、より情報が必要なときはたいてい、help()を使って必要な情報をすぐに見つけることができます。

たとえば、

>>> help(max) Help on built-in function max in module builtins: max(...) max(iterable, *[, default=obj, key=func]) -> value max(arg1, arg2, *args, *[, key=func]) -> value With a single iterable argument, return its biggest item. The default keyword-only argument specifies an object to return if the provided iterable is empty. With two or more arguments, return the largest argument.更なる情報へのアクセスはなかなか役立つので、IPythonは?をドキュメンテーションと関連した他の情報にアクセスするための略号として用います。IPythonは複数の言語で使える、インタラクティブな計算を行うためのコマンドシェルです。IPythonについてのさらなる情報はこちら。

たとえば、

In [0]: max? max(iterable, *[, default=obj, key=func]) -> value max(arg1, arg2, *args, *[, key=func]) -> value With a single iterable argument, return its biggest item. The default keyword-only argument specifies an object to return if the provided iterable is empty. With two or more arguments, return the largest argument. Type: builtin_function_or_methodこの表記法を、オブジェクトメソッドやオブジェクトそのものにさえ使うことができます。

次の配列を作ったとしましょう。

>>> a = np.array([1, 2, 3, 4, 5, 6])すると、たくさんの役立つ情報を得ることができます(最初にオブジェクトそのものの詳細、次にaがインスタンスであるndarrayのdocstringが続きます)。

In [1]: a? Type: ndarray String form: [1 2 3 4 5 6] Length: 6 File: ~/anaconda3/lib/python3.7/site-packages/numpy/__init__.py Docstring: <no docstring> Class docstring: ndarray(shape, dtype=float, buffer=None, offset=0, strides=None, order=None) An array object represents a multidimensional, homogeneous array of fixed-size items. An associated data-type object describes the format of each element in the array (its byte-order, how many bytes it occupies in memory, whether it is an integer, a floating point number, or something else, etc.) Arrays should be constructed using `array`, `zeros` or `empty` (refer to the See Also section below). The parameters given here refer to a low-level method (`ndarray(...)`) for instantiating an array. For more information, refer to the `numpy` module and examine the methods and attributes of an array. Parameters ---------- (for the __new__ method; see Notes below) shape : tuple of ints Shape of created array. ...これはあなたが作成した関数や他のオブジェクトにも作用します。ただ。関数内に文字リテラルを使ってdocstringを入れるのを忘れないで下さい(

""" """か''' '''でドキュメンテーションを囲む)。たとえば、次の関数を作った場合、

>>> def double(a): ... '''Return a * 2''' ... return a * 2この関数について情報を得るには、次のようにします。

In [2]: double? Signature: double(a) Docstring: Return a * 2 File: ~/Desktop/<ipython-input-23-b5adf20be596> Type: function関心あるオブジェクトのソースコードを読むことで、また違った水準の情報に触れることができます。二重疑問符(??)を使うことで、ソースコードにアクセスできます。

たとえば、

In [3]: double?? Signature: double(a) Source: def double(a): '''Return a * 2''' return a * 2 File: ~/Desktop/<ipython-input-23-b5adf20be596> Type: function当該のオブジェクトがPython以外の言語でコンパイルされている場合、??を使うと?と同じ情報が返ってきます。このことは、たくさんの組み込みオブジェクトやタイプで見ることができます。たとえば、

In [4]: len? Signature: len(obj, /) Docstring: Return the number of items in a container. Type: builtin_function_or_methodそして :

In [5]: len?? Signature: len(obj, /) Docstring: Return the number of items in a container. Type: builtin_function_or_methodこれらが同一の出力なのは、これらがPythonではない言語でコンパイルされているからです。

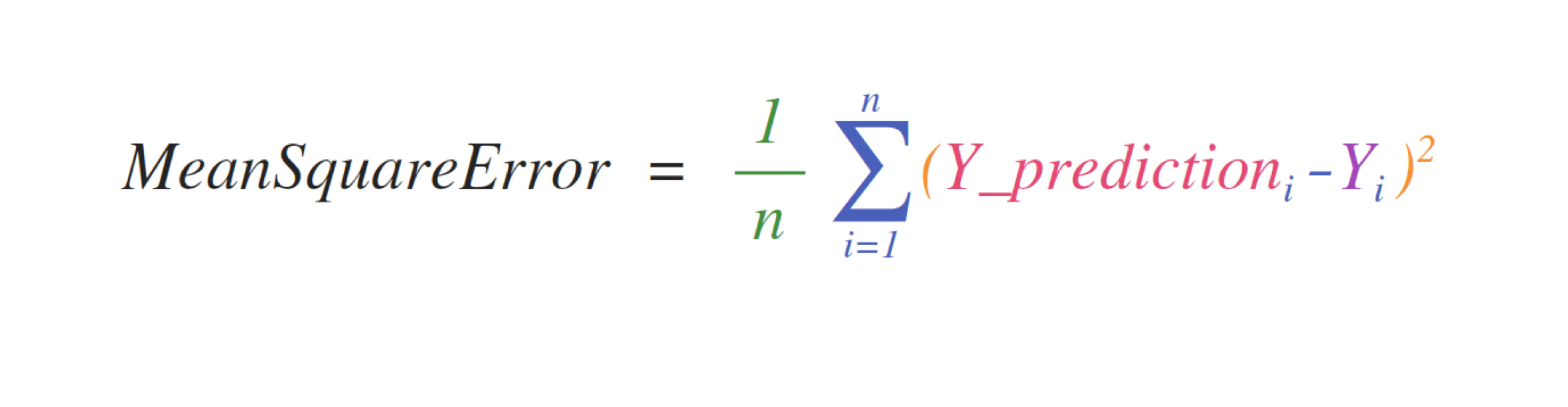

数式を扱う

NumPyが科学のPythonコミュニティでここまで広く使われている理由の一つに、配列上で作用する数式を簡単に実装できることがあります。

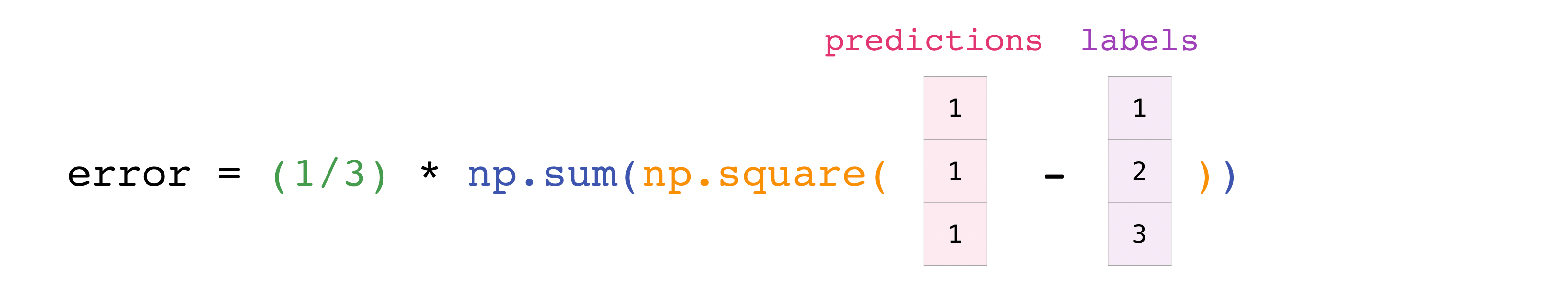

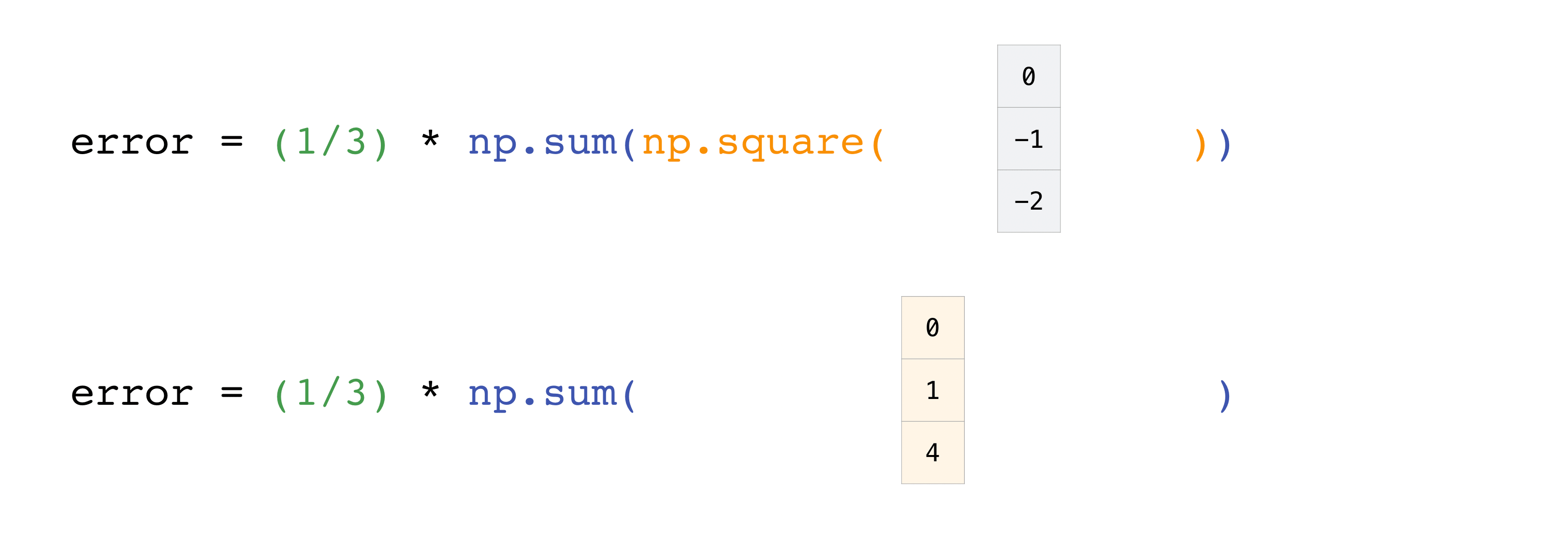

たとえば、これが平均二乗誤差(回帰を扱う教師付き機械学習モデルで使われる中心的な公式)です。

この式の実装はNumPyではシンプルで式そのままです:

error = (1/n) * np.sum(np.square(predictions - labels))これが非常にうまく機能するのは、予測値とラベルが1個でも1000個の値でも含むことができるからです。必要なのは、予測値とラベルが同じサイズであることだけです。

これは次のように可視化することができます。

この例では、予測とラベルは3つの値をもつベルトルであり、それゆえnは3という値をとります。引き算を行った後、ベクトルの値は二乗されます。そしてNumPyが値を合計し、その結果が予測値の誤差とモデルの品質のスコアとなります。

NumPyをセーブ・ロードする方法

この節は

np.save,np.savez,np.savetxt,np.load,np.loadtxtを扱いますいつか、配列をディスクに保存して、コードをもう一度実行することなくロードしたいと思うことがあるでしょう。さいわい、NumPyではオブジェクトを保存したりロードしたりする方法がいくつかあります。ndarrayオブジェクトは、

loadtxtとsavetxt関数で通常のテキストファイルをロード・セーブし、loadandsave関数で.npz拡張子のNumPyバイナリファイルを扱うことができます。そして、savez関数で.npz拡張子のNumpyファイルを扱うことができます。.npyと .npzファイルは、ファイルが異なるアーキテクチャ上でも正しく復旧できるように、データ、形状、dtypeやその他の、ndarrayを再構築するために必要な情報を格納しています。

1つのndarrayオブジェクトを保存したい場合、np.saveを使って.npyファイルとして保存してください。複数のndarrayを配列に保存したい場合、np.savezを使って.npzとして保存してください。また、savez_compressedを用いて圧縮されたnpz形式で保存することで、複数の配列を1つのファイルに保存することもできます。

np.save()でセーブ・ロード・配列するのは簡単です(It’s easy to save and load and array with np.save().)。保存したい配列とファイルネームを指定することを忘れないでください。たとえば、この配列をつくった場合、>>> a = np.array([1, 2, 3, 4, 5, 6])"filename.npy"として保存できます。

>>> np.save('filename', a)np.load()で配列を復元できます。

>>> b = np.load('filename.npy')もし配列を確かめたいなら、このコードを実行すればよいです。

>>> print(b) [1 2 3 4 5 6]np.savetxtを使えば、.csvや.txtファイルのようなプレーンテキストとしてNumPyファイルを保存できます。

たとえば、次の配列を作った場合、

>>> csv_arr = np.array([1, 2, 3, 4, 5, 6, 7, 8]) ```shell You can easily save it as a .csv file with the name “new_file.csv” like this: ```shell >>> np.savetxt('new_file.csv', csv_arr)loadtxt()を使って、簡単に保存したテキストファイルを読み込めます。

>>> np.loadtxt('new_file.csv') array([1., 2., 3., 4., 5., 6., 7., 8.])savetxt()とloadtxt()関数はヘッダー、フッター、区切り文字といった追加パラメーターを受け付けます。テキストファイルは共有に便利な一方で、.npyと.npzファイルは小さく、読み書きが高速です。もしテキストファイルのもっと洗練された取り扱いが必要なら(たとえば欠損値を含む行列[lines]を扱う場合)、

genfromtxt関数を使う必要があるでしょう。

savetxtを使うとき、ヘッダー、フッター、コメントなどを指定することができます。Learn more about input and output routines here.

CSVをインポート・エクスポートする方法

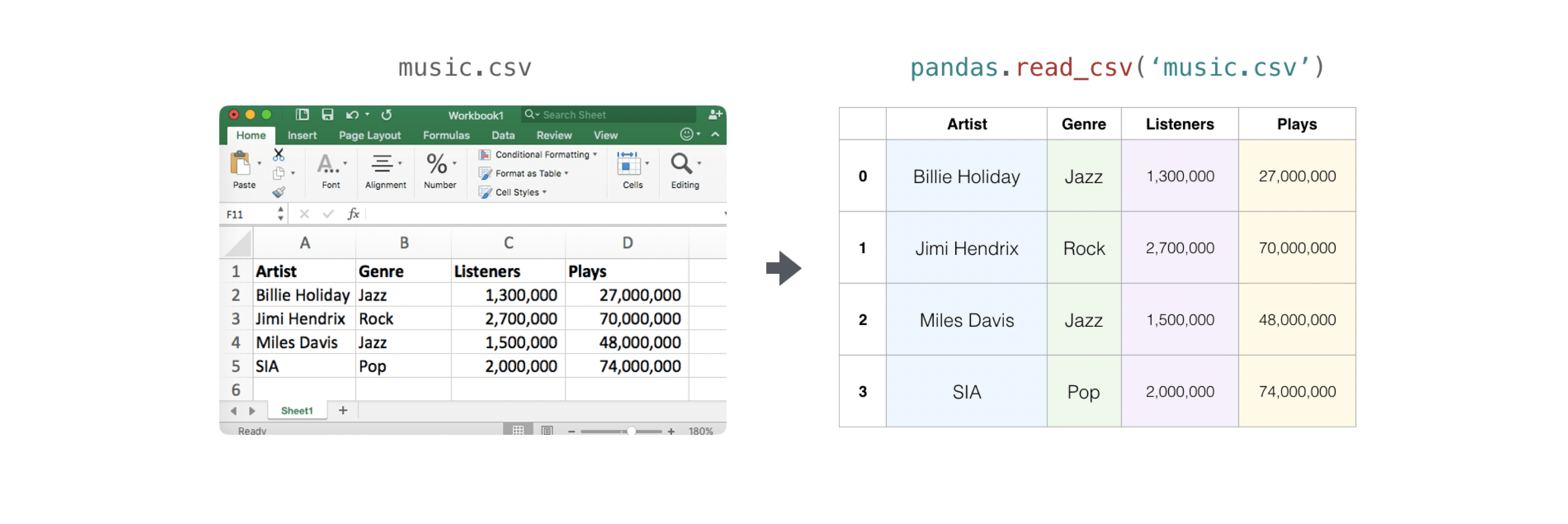

既存の情報が入っているCSVファイルを読み込むのは簡単です。最も簡単な方法はPandasを使うことです。

>>> import pandas as pd >>> # If all of your columns are the same type: >>> x = pd.read_csv('music.csv', header=0).values >>> print(x) [['Billie Holiday' 'Jazz' 1300000 27000000] ['Jimmie Hendrix' 'Rock' 2700000 70000000] ['Miles Davis' 'Jazz' 1500000 48000000] ['SIA' 'Pop' 2000000 74000000]] >>> # You can also simply select the columns you need: >>> x = pd.read_csv('music.csv', usecols=['Artist', 'Plays']).values >>> print(x) [['Billie Holiday' 27000000] ['Jimmie Hendrix' 70000000] ['Miles Davis' 48000000] ['SIA' 74000000]]配列のエクスポートもPandasを使えば簡単です。NumPyに慣れていない方は、配列の値からPandasデータフレームを作り、そのデータフレームをPandasでCSVファイルに書き出すのが良いでしょう。

配列"a"を作ったとしましょう。

>>> a = np.array([[-2.58289208, 0.43014843, -1.24082018, 1.59572603], ... [ 0.99027828, 1.17150989, 0.94125714, -0.14692469], ... [ 0.76989341, 0.81299683, -0.95068423, 0.11769564], ... [ 0.20484034, 0.34784527, 1.96979195, 0.51992837]])Pandasデータフレームを次のように作成できます。

>>> df = pd.DataFrame(a) >>> print(df) 0 1 2 3 0 -2.582892 0.430148 -1.240820 1.595726 1 0.990278 1.171510 0.941257 -0.146925 2 0.769893 0.812997 -0.950684 0.117696 3 0.204840 0.347845 1.969792 0.519928次のようにしてデータフレームを保存できます。

>>> df.to_csv('pd.csv')CSVはこう

>>> data = pd.read_csv('pd.csv')

NumPyのsavetxtメソッドを使って保存することもできます。

>>> np.savetxt('np.csv', a, fmt='%.2f', delimiter=',', header='1, 2, 3, 4')コマンドラインを使っているなら、次のようなコマンドで保存したCSVをいつでも読み込むことができます。

$ cat np.csv # 1, 2, 3, 4 -2.58,0.43,-1.24,1.60 0.99,1.17,0.94,-0.15 0.77,0.81,-0.95,0.12 0.20,0.35,1.97,0.52または、テキストエディタでいつでも開くことができます。

Pandasについてもっと詳しく知りたい方は、official Pandas documentationを見てみてください。Pandasをインストールする方法については、official Pandas installation informationを参照してください。

Matplotlibで配列をプロットする

値のプロットを作成する必要がある場合、Matplotlibを使用すると非常に簡単です。

たとえば、このような配列があるかもしれません。

>>> a = np.array([2, 1, 5, 7, 4, 6, 8, 14, 10, 9, 18, 20, 22])Matplotlibをすでにインストールしているなら、このようにインポートできます。

>>> import matplotlib.pyplot as plt # If you're using Jupyter Notebook, you may also want to run the following # line of code to display your code in the notebook: %matplotlib inline値をプロットするには、面倒な操作はいりません。

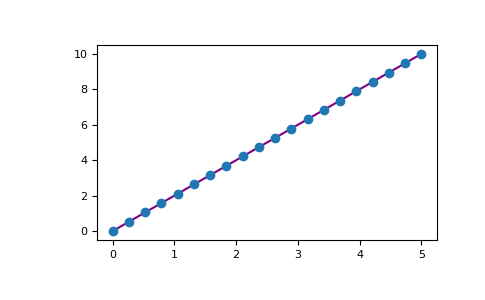

>>> plt.plot(a) # If you are running from a command line, you may need to do this: # >>> plt.show()たとえば、1D配列を次のようにプロットできます。

‘>>> x = np.linspace(0, 5, 20) >>> y = np.linspace(0, 10, 20) >>> plt.plot(x, y, 'purple') # line >>> plt.plot(x, y, 'o') # dotsMatplotlibでは、膨大な数の可視化オプションを使うことができます。

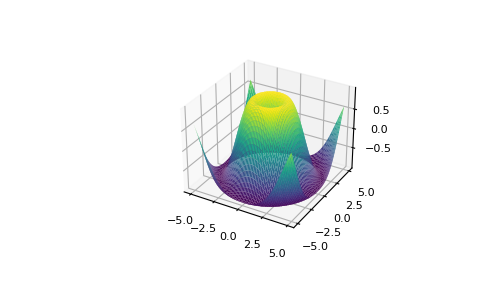

>>> from mpl_toolkits.mplot3d import Axes3D >>> fig = plt.figure() >>> ax = Axes3D(fig) >>> X = np.arange(-5, 5, 0.15) >>> Y = np.arange(-5, 5, 0.15) >>> X, Y = np.meshgrid(X, Y) >>> R = np.sqrt(X**2 + Y**2) >>> Z = np.sin(R) >>> ax.plot_surface(X, Y, Z, rstride=1, cstride=1, cmap='viridis')To read more about Matplotlib and what it can do, take a look at the official documentation. For directions regarding installing Matplotlib, see the official installation section.

mage credits: Jay Alammar http://jalammar.github.io/

- 投稿日:2020-10-21T23:05:32+09:00

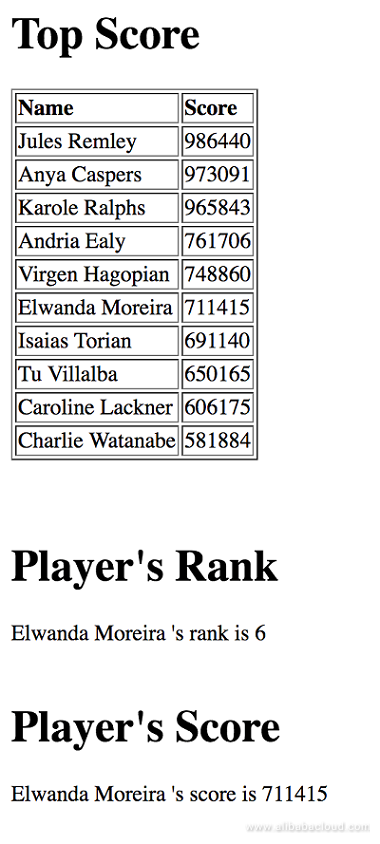

How to install richzhang/colorization on Windows 10

What is this?

This document shows you how to install Colorful Image Colorization on Windows 10 and Python 3.x (3.8.6).

Steps

Step 1. Install Python on Windows

Version 3.8 of Windows x86-64 executable installer seems better:

https://www.python.org/downloads/windows/Step 2. Install richzhang/colorization

Clone the repository

git clone https://github.com/richzhang/colorization.gitCUDA

Download and install CUDA 10.2:

https://developer.nvidia.com/cuda-downloadsPyTorch (torch)

pip install torch===1.6.0 torchvision===0.7.0 -f https://download.pytorch.org/whl/torch_stable.html # For more details see below # https://stackoverflow.com/questions/56859803/modulenotfounderror-no-module-named-tools-nnwrapOthers

Please note that I chose

scikit-imageinstead ofskimage.pip install wheel scikit-image matplotlib argparse pip install ipythonStep 3. Run

cd colorization python demo_release.py -i imgs/ansel_adams3.jpgCongratulations!

Logs

PyTorch (torch)

Click here to see command-line logs

C:\Users\AAA>pip install torch===1.6.0 torchvision===0.7.0 -f https://download.pytorch.org/whl/torch_stable.html Looking in links: https://download.pytorch.org/whl/torch_stable.html Collecting torch===1.6.0 Downloading https://download.pytorch.org/whl/cu102/torch-1.6.0-cp38-cp38-win_amd64.whl (1077.4 MB) |████████████████████████████████| 1077.4 MB 833 bytes/s Collecting torchvision===0.7.0 Downloading https://download.pytorch.org/whl/cu102/torchvision-0.7.0-cp38-cp38-win_amd64.whl (1.1 MB) |████████████████████████████████| 1.1 MB 6.8 MB/s Collecting future Downloading future-0.18.2.tar.gz (829 kB) |████████████████████████████████| 829 kB 3.2 MB/s Collecting numpy Downloading numpy-1.19.2-cp38-cp38-win_amd64.whl (13.0 MB) |████████████████████████████████| 13.0 MB 6.8 MB/s Collecting pillow>=4.1.1 Downloading Pillow-8.0.0-cp38-cp38-win_amd64.whl (2.1 MB) |████████████████████████████████| 2.1 MB 6.4 MB/s Using legacy 'setup.py install' for future, since package 'wheel' is not installed. Installing collected packages: future, numpy, torch, pillow, torchvision Running setup.py install for future ... done Successfully installed future-0.18.2 numpy-1.19.2 pillow-8.0.0 torch-1.6.0 torchvision-0.7.0

PILseems to be the name used in Python 2.x, andpillowseems to be the name used in Python 3.x.

Others

Click here to see command-line logs

C:\Users\AAA>pip install wheel scikit-image matplotlib argparse Collecting wheel Using cached wheel-0.35.1-py2.py3-none-any.whl (33 kB) Collecting scikit-image Downloading scikit_image-0.17.2-cp38-cp38-win_amd64.whl (11.7 MB) |████████████████████████████████| 11.7 MB 3.3 MB/s Collecting matplotlib Downloading matplotlib-3.3.2-cp38-cp38-win_amd64.whl (8.5 MB) |████████████████████████████████| 8.5 MB 6.4 MB/s Collecting argparse Using cached argparse-1.4.0-py2.py3-none-any.whl (23 kB) Collecting scipy>=1.0.1 Downloading scipy-1.5.3-cp38-cp38-win_amd64.whl (31.4 MB) |████████████████████████████████| 31.4 MB 6.4 MB/s Collecting imageio>=2.3.0 Downloading imageio-2.9.0-py3-none-any.whl (3.3 MB) |████████████████████████████████| 3.3 MB ... Requirement already satisfied: pillow!=7.1.0,!=7.1.1,>=4.3.0 in c:\home\sdk\python38\lib\site-packages (from scikit-image) (8.0.0) Collecting tifffile>=2019.7.26 Downloading tifffile-2020.10.1-py3-none-any.whl (152 kB) |████████████████████████████████| 152 kB 6.8 MB/s Collecting PyWavelets>=1.1.1 Downloading PyWavelets-1.1.1-cp38-cp38-win_amd64.whl (4.3 MB) |████████████████████████████████| 4.3 MB 6.8 MB/s Requirement already satisfied: numpy>=1.15.1 in c:\home\sdk\python38\lib\site-packages (from scikit-image) (1.19.2) Collecting networkx>=2.0 Downloading networkx-2.5-py3-none-any.whl (1.6 MB) |████████████████████████████████| 1.6 MB ... Collecting pyparsing!=2.0.4,!=2.1.2,!=2.1.6,>=2.0.3 Using cached pyparsing-2.4.7-py2.py3-none-any.whl (67 kB) Collecting certifi>=2020.06.20 Using cached certifi-2020.6.20-py2.py3-none-any.whl (156 kB) Collecting python-dateutil>=2.1 Using cached python_dateutil-2.8.1-py2.py3-none-any.whl (227 kB) Collecting cycler>=0.10 Using cached cycler-0.10.0-py2.py3-none-any.whl (6.5 kB) Collecting kiwisolver>=1.0.1 Downloading kiwisolver-1.2.0-cp38-none-win_amd64.whl (58 kB) |████████████████████████████████| 58 kB ... Collecting decorator>=4.3.0 Downloading decorator-4.4.2-py2.py3-none-any.whl (9.2 kB) Collecting six>=1.5 Using cached six-1.15.0-py2.py3-none-any.whl (10 kB) Installing collected packages: wheel, scipy, imageio, tifffile, PyWavelets, pyparsing, certifi, six, python-dateutil, cycler, kiwisolver, matplotlib, decorator, networkx, scikit-image, argparse Successfully installed PyWavelets-1.1.1 argparse-1.4.0 certifi-2020.6.20 cycler-0.10.0 decorator-4.4.2 imageio-2.9.0 kiwisolver-1.2.0 matplotlib-3.3.2 networkx-2.5 pyparsing-2.4.7 python-dateutil-2.8.1 scikit-image-0.17.2 scipy-1.5.3 six-1.15.0 tifffile-2020.10.1 wheel-0.35.1

c:\home\sdk\python38is a directory name that is unique to my environment.

First run

Click here to see command-line logs

C:\home\src\colorization>python demo_release.py -i imgs/ansel_adams3.jpg Downloading: "https://colorizers.s3.us-east-2.amazonaws.com/colorization_release_v2-9b330a0b.pth" to C:\Users\AAA/.cache\torch\hub\checkpoints\colorization_release_v2-9b330a0b.pth 100.0% Downloading: "https://colorizers.s3.us-east-2.amazonaws.com/siggraph17-df00044c.pth" to C:\Users\AAA/.cache\torch\hub\checkpoints\siggraph17-df00044c.pth 100.0% C:\home\sdk\python38\lib\site-packages\torch\nn\functional.py:3118: UserWarning: Default upsampling behavior when mode=bilinear is changed to align_corners=False since 0.4.0. Please specify align_corners=True if the old behavior is desired. See the documentation of nn.Upsample for details. warnings.warn("Default upsampling behavior when mode={} is changed " C:\home\sdk\python38\lib\site-packages\skimage\color\colorconv.py:1128: UserWarning: Color data out of range: Z < 0 in 367 pixels return xyz2rgb(lab2xyz(lab, illuminant, observer)) C:\home\sdk\python38\lib\site-packages\skimage\color\colorconv.py:1128: UserWarning: Color data out of range: Z < 0 in 33 pixels return xyz2rgb(lab2xyz(lab, illuminant, observer))Note

This page is a clone of the Zenn article.

- 投稿日:2020-10-21T22:48:13+09:00

フレーム数を見ながら動画再生する方法(Mac)

動画をコマ送りしながらチェックして気になる場面のフレーム数を知りたいケースが多い。

割とありそうな需要にもかかわらず最近の動画プレーヤーは秒表示しかできなくて調べても全然方法が出てこない。

なんとかならないかと必死で調べて苦肉の策としての対応を見つけたのでメモ。

他にいい方法あれば是非教えてください。

なんでこんな基本的なことができるプレーヤーがないんだろうか。(QuictimePlayer7はできたらしいけれど32bitアプリは今は動かせない。)方法

mpvというプレーヤーを少しだけ書き換えてコンパイルします。

まずGitからソースコードをダウンロード。書き換えるのはplayer/osd.cのget_term_status_msg関数の中に一行追加するだけ。(今のバージョンだと200行目くらい)

// Playback position sadd_hhmmssff(&line, get_playback_time(mpctx), opts->osd_fractions); saddf(&line, " / "); sadd_hhmmssff(&line, get_time_length(mpctx), opts->osd_fractions); sadd_percentage(&line, get_percent_pos(mpctx)); /////////// 追加 //////////////// line = talloc_asprintf_append(line, " (%d frame)", (int)(mpctx->video_pts * mpctx->tracks[0]->stream->codec->fps+0.5)); /////////// ここまで ////////////あとはREADMEにしたがってコンパイルしてインストールする。

するとターミナルの再生時刻の表示の末尾にフレーム数が表示されるようになります。

(Paused) V: 00:00:00 / 00:00:03 (21%) (19 frame)

- 投稿日:2020-10-21T22:23:47+09:00

pythonでシーザー暗号を作成、復号する

# substitute PLAIN the letter PLAIN = "EBG KVVV vf n fvzcyr yrggre fhofgvghgvba pvcure gung ercynprf n yrggre jvgu gur yrggre KVVV yrggref nsgre vg va gur nycunorg. EBG KVVV vf na rknzcyr bs gur Pnrfne pvcure, qrirybcrq va napvrag Ebzr. Synt vf SYNTFjmtkOWFNZdjkkNH. Vafreg na haqrefpber vzzrqvngryl nsgre SYNT." for i in range(26): KEY = i enc = "" for char in list(PLAIN): ASCII = ord(char) if (ASCII == 32): # if ASCII is SPC, make space. enc += " " continue if (122 >= ASCII and ASCII >= 97): # if ASCII is lower num = ASCII - 97 num = (num + KEY) % 26 ASCII = num + 97 enc += chr(ASCII) elif (90 >= ASCII and ASCII >= 65): # if ASCII is upper num = ASCII - 65 num = (num + KEY) % 26 ASCII = num + 65 enc += chr(ASCII) else : # if ASCII is symbol enc += chr(ASCII) print(f"--------- Shifted {i} character ---------") print(enc) print("")使いたい方はこのコードをコピーし、適当な名前を付けて保存してください。拡張子を「.py」にするのをお忘れなく(例、test.py)

そのあと、コードの一番上にあるPLAIN変数の中身を暗号にしたい文字や解読したい文字にしてください。(例、PLAIN = "hogehoge")

その状態で保存し、実行しします。

# python test.pyそうすると、1~25文字ずらした文字列を表示されます。(アルファベットは全部で26文字です。)

- 投稿日:2020-10-21T21:52:31+09:00

django-filterの使い方を理解する

django-filterとは

検索条件を短いコードで書くことができます!!!

僕的にはこれを知った時には革命的だと思いました。※この記事では、Django Rest Frameworkの使用と初期設定は終わっている想定です!!!!!!!

modelとseiralizerを定義

サンプルになりますが、このようなモデルとシリアライザを定義しておきます。

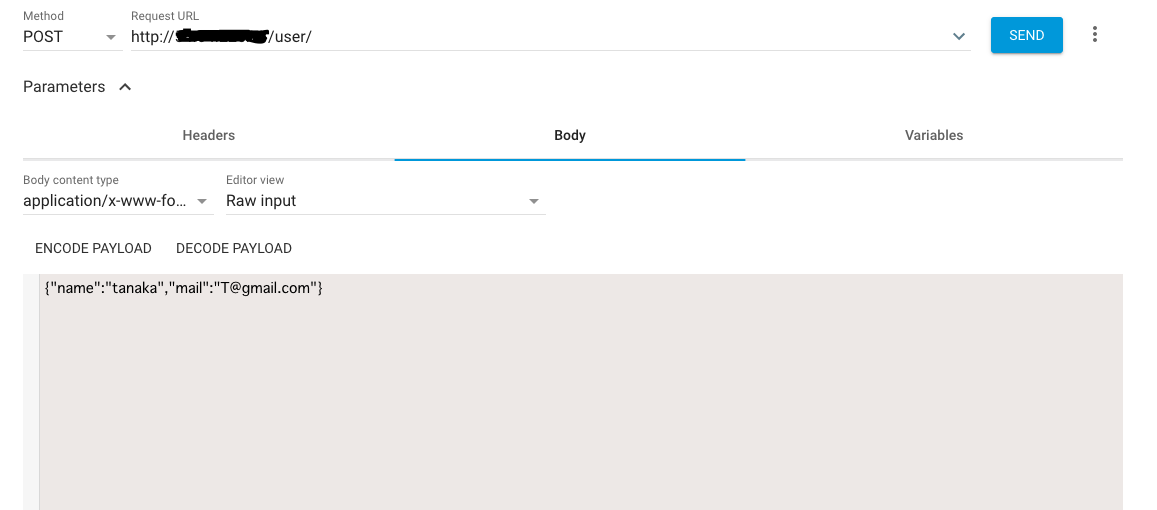

models.pyclass Book(models.Model): id = models.UUIDField(primary_key=True, default=uuid.uuid4, editable=False) is_deleted = models.CharField(max_length=1, default='0') created_at = models.DateTimeField(auto_now_add=True) updated_at = models.DateTimeField(auto_now=True) title = models.CharField(max_length=128) sub_title = models.CharField(max_length=128) price = models.DecimalField(max_digits=8, decimal_places=2, blank=True, null=True) author = models.ForeignKey(Author, on_delete=models.PROTECT, blank=True, null=True) publisher = models.ForeignKey(Publisher, on_delete=models.PROTECT)serializer.pyclass BookSerializer(serializers.ModelSerializer): class Meta: model = Book fields = '__all__'基本的な書き方

まずは手始めにdjango-filterで

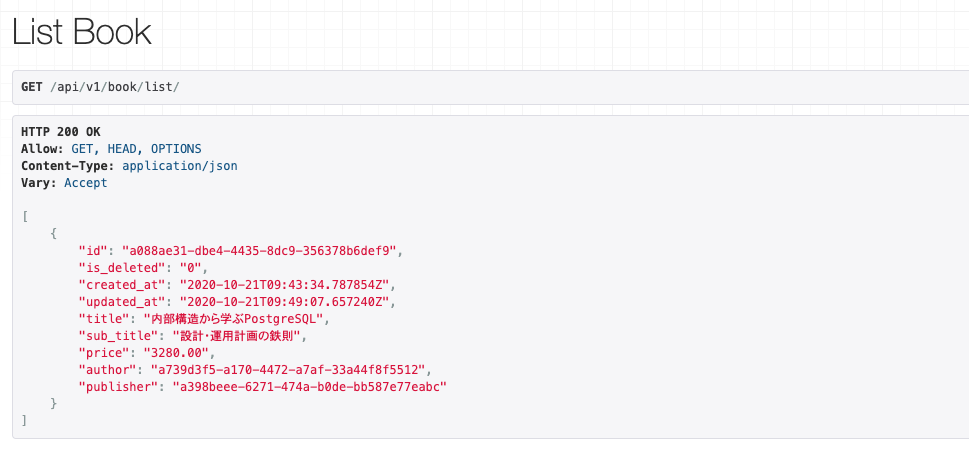

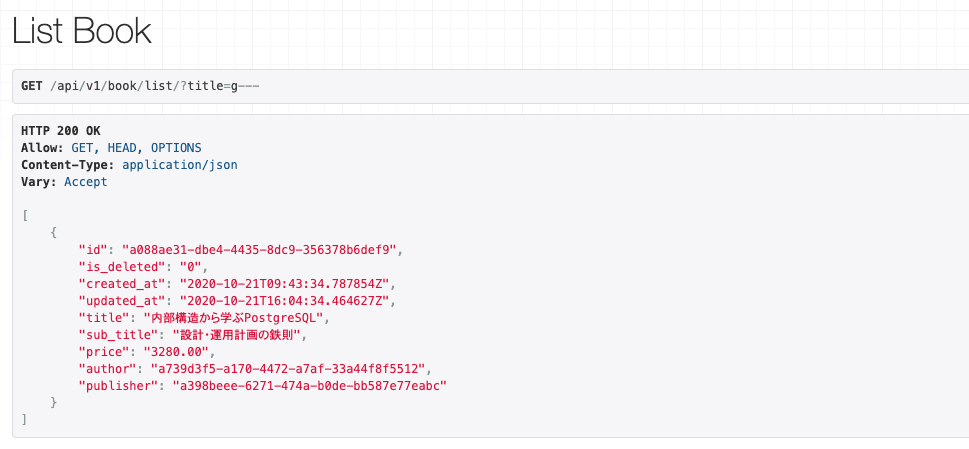

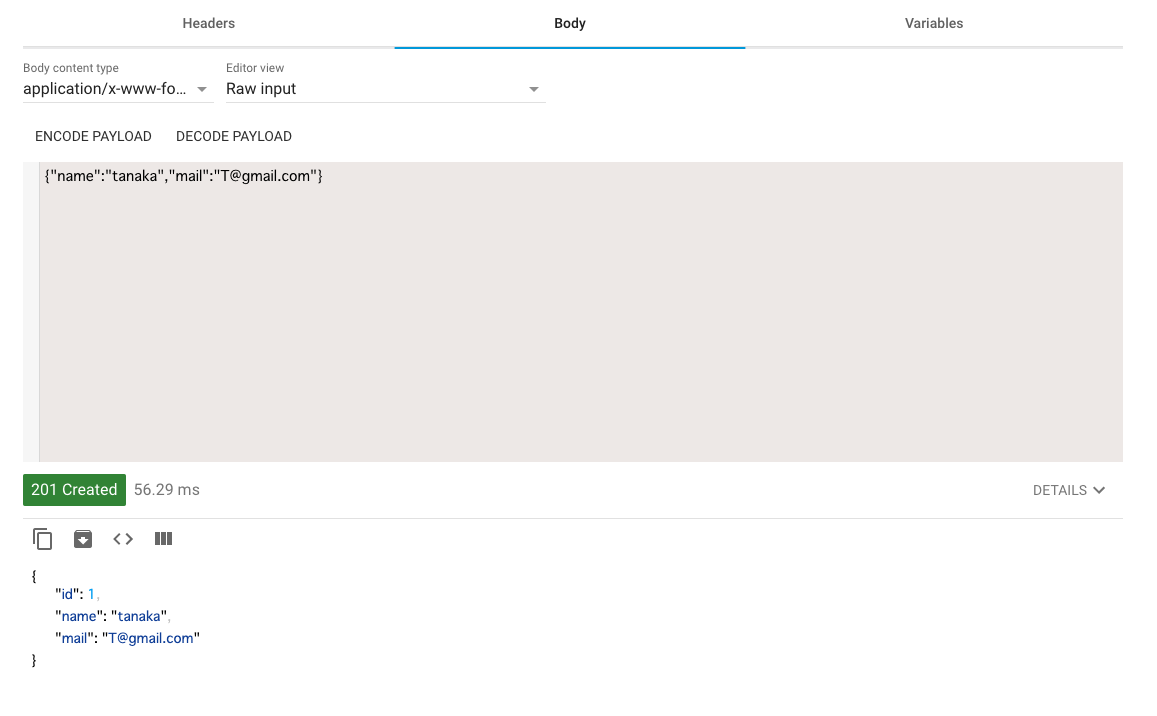

検索条件などで絞り込まずに一覧の取得を行ってみます。view.pyfrom django_filters import rest_framework as filters class FilterBook(filters.FilterSet): class Meta: model = Book fields = '__all__' class ListBook(APIView): def get(self, request): filterset = FilterBook(request.query_params, queryset=Book.objects.all()) serializer = BookSerializer(instance=filterset.qs, many=True) return Response(serializer.data)FilterSetを継承したクラスを作成して、そこでモデルを指定します。

DjangoのFormやSerializerに似ていますね。そしてこの作成したListBookAPIのURL

/api/v1/book/list/(省いています。)

にブラウザからリクエストすると、このようなデータがレスポンスされます。

もちろんデータはサンプルです笑検索条件を指定する

それでは検索条件を指定してリクエストする。

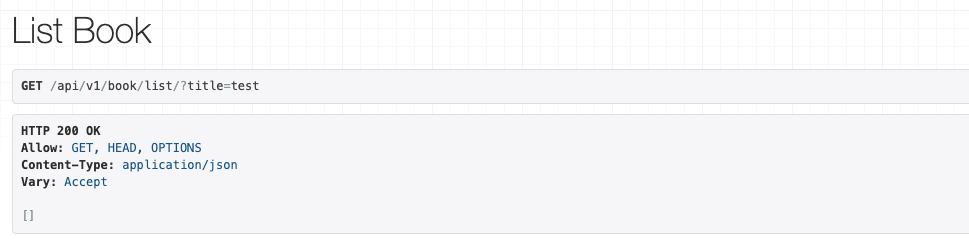

先ほどリクエストしたURLは/api/v1/book/list/でしたが、そこのクエリパラメータを指定します。

/api/v1/book/list/?title=testに変更してリクエストするとレスポンスが変わります。今回のレスポンスは何も返却されませんでした。

このtitle=testというのは、Bookモデルのtitleがtestに一致するオブジェクトを返します。

その他にもtitleをsub_titleに変更して、/api/v1/book/list/?sub_title=testに

リクエストをしてもレスポンスは何にも返ってきません。ただし、クエリパラメータをBookモデルに存在しないフィールドを指定すると

絞り込みができず、レスポンスにデータが返ってきます。検索条件を変更する

先ほどは、

titleやsub_titleで絞り込んで

データを抽出しました。ただ今回は、

titleは検索条件でいいけど、sub_titleは検索条件として要らない!

なんてことがあるかと思います。

そんな時は、Filterクラスのfieldsで、該当のみに指定することができます。views.pyclass FilterBook(filters.FilterSet): class Meta: model = Book fields = ['title']このようにすることで、先ほどは

sub_titleで絞り込みできていましたが、titleでしか絞り込みができなくなりました。検索方法をカスタマイズする

先ほどfieldsを

__all__で指定した場合だと、デフォルトの検索方法になってしまい

数値の検索や、部分一致などの検索方法が使えませんでした。

(例えば、/api/v1/book/list/?price=testにリクエストしても、絞り込みはされません。)そこで、検索方法をカスタマイズしていきます。

views.pyclass FilterBook(filters.FilterSet): # UUID id = filters.UUIDFilter() # 部分一致 title = filters.CharFilter(lookup_expr='icontains') # 金額を調べる price = filters.NumberFilter() price__gt = filters.NumberFilter(field_name='price', lookup_expr='gt') price__lt = filters.NumberFilter(field_name='price', lookup_expr='lt') class Meta: model = Book fields = []カスタマイズの内容です。

filters.UUIDFilter()は、UUIDへの対応です。IDで検索かけても引っかかるようになりました。

filters.CharFilter(lookup_expr='icontains')で

部分一致にしました。このlookup_exprの引数は、Djangoのfield lookups

と同じ指定ができます。

filters.NumberFilter(field_name='price', lookup_expr='gt')

は数値の対応と範囲を指定しています。

field_nameは、モデルの対象フィールドを指定します。

通常はフィルターのフィールド名とモデルのフィールド名で一致していれば、指定しなくても問題ありません。

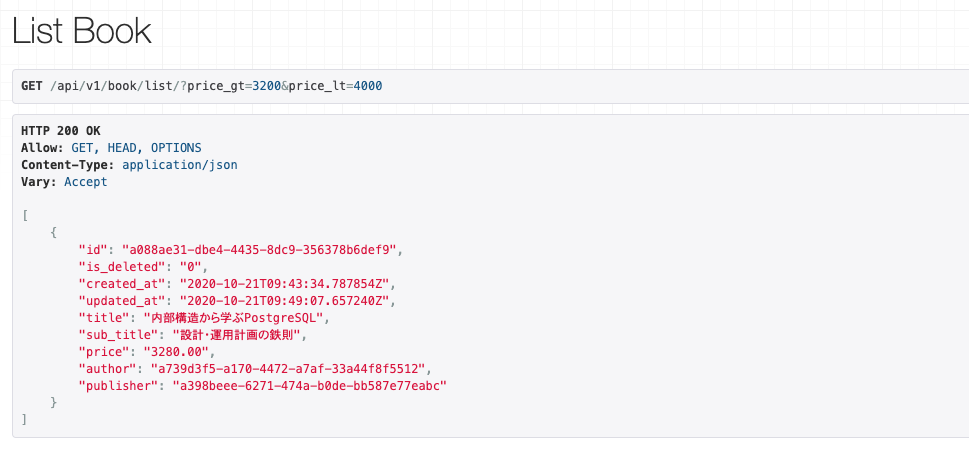

それではカスタマイズ後にリクエストをします。

api/v1/book/list/?title=sqlや

api/v1/book/list/?price_gt=3200&price_lt=4000

にリクエストしても、データがレスポンスされるようになりました。リレーションにも対応する

ForeignKeyで結びついたモデルも検索条件にしたい場合は、

field_nameに指定します。

指定方法はdjangoのlookup式で対応できます。views.pyclass FilterBook(filters.FilterSet): author_last_name = filters.CharFilter(field_name='author__last_name',lookup_expr='icontains')デフォルトのフィルターをカスタマイズする

デフォルトのフィルターでは、CharFilterが完全一致だったりでフィールドごとにカスタマイズする必要がありました。

フィールドごとにカスタマイズするのではなく、CharFilterのデフォルトをカスタマイズしようということです。views.pyclass FilterBook(filters.FilterSet): class Meta: model = Book fields = ['title'] filter_overrides = { models.CharField: { 'filter_class': filters.CharFilter, 'extra': lambda f: { 'lookup_expr': 'icontains', }, }, }

class Meta:にfilter_overrridesとデフォルトの設定にしたい内容を記載します。

今回これで、モデルにCharFiledを使っているフィールドは、デフォルトで全て部分一致になりました。独自のカスタマイズをする

絞りこむ際に独自の検索を行うことができます。

ハイフンを取り除き、部分一致にする例を作成しました。views.pyclass FilterBook(filters.FilterSet): title = filters.CharFilter(method='title_custom_filter') class Meta: model = Book fields = [] @staticmethod def title_custom_filter(queryset, name, value): # nameはフィールド名前 # valueはクエリパラメータ # name__icontains lookup = '__'.join([name, 'icontains']) # ハイフンを消す replaced_value = value.replace('-', '') return queryset.filter(**{ lookup: replaced_value, })

CharFilterの引数にメソッドの名前を文字列で渡すと、そのメソッドが検索時に実行されます。

nameにフィールド名、value検索のパラメータが渡されます。

なのでそこを変更すれば、自由に検索条件が作成できる分けです。今回では、例えば

/api/v1/book/list/?title=gと同じように

/api/v1/book/list/?title=g---

にリクエストを送信してもレスポンスがくるようになりました。

この他の詳しい情報は、

ぜひ公式ドキュメントを

ご確認いただければとおもいます!!!!!!!!!!!!!!!!!

- 投稿日:2020-10-21T21:35:28+09:00

pytest-mockのよく使う実装方法をまとめてみた

pytest-mockの使い方を調べたのでメモ

今後も使いそうなユースケースを都度調べるのが面倒なのでまとめてみました。

pytestを調べてから1日で書いた記事なので色々過不足があると思いますが、もっと良い方法が見つかったら随時アップデートしていきたいと思います。pytest、pytest-mockについて

pythonのテストコードを実装するときに使うライブラリの1つです。

詳細は公式ホームページを参照してください。pytest

https://docs.pytest.org/en/latest/index.html

pytest-mock

https://pypi.org/project/pytest-mock/

説明に使うメソッド

下記のhogeメソッドをテスト対象とします。

from mailer import Mailer # messagesの例 # ['1通目の本文', '2通目の本文'] def hoge(messages): try: # messagesの数だけメール送信 for message in messages: has_error = Mailer.send(message) if has_error: # エラー発生時は1を返却 return 1 # 正常終了時は0を返却 return 0 except Exception as e: # 例外発生時は2を返却 return 2この記事を書いたときに使ったバージョンは下記の通りです。

- python 3.8.5

- pytest 6.1.1

- pytest-mock 3.3.1

Mailer.sendをモックに差し替えるtest_hoge.pyfrom hoge import hoge from mailer import Mailer from unittest.mock import call def test_hoge(mocker): # Mailer.sendをモックに差し替える mailer_mock = mocker.patch.object(Mailer, 'send') messages = ['1通目の本文', '2通目の本文'] # 上記でMailer.sendをモックにしているのでhogeを実行しても本物のMailer.sendは実行されません assert hoge(messages) == 0呼び出し回数を検証したい

test_hoge.pyfrom hoge import hoge from mailer import Mailer from unittest.mock import call def test_hoge(mocker): # Mailer.sendをモックに差し替える mailer_mock = mocker.patch.object(Mailer, 'send') messages = ['1通目の本文', '2通目の本文'] assert hoge(messages) == 0 # Mailer.sendが2回呼ばれることを確認できます assert mailer_mock.call_count == 2呼び出されないことを検証したい

test_hoge.pyfrom hoge import hoge from mailer import Mailer from unittest.mock import call def test_hoge(mocker): # Mailer.sendをモックに差し替える mailer_mock = mocker.patch.object(Mailer, 'send') # messagesが空なのでMailer.sendは呼ばれないようにする messages = [] assert hoge(messages) == 0 # Mailer.sendが呼ばれないことを検証 mailer_mock.assert_not_called()パラメーターを検証したい

test_hoge.pyfrom hoge import hoge from mailer import Mailer from unittest.mock import call def test_hoge(mocker): # Mailer.sendをモックに差し替える mailer_mock = mocker.patch.object(Mailer, 'send') messages = ['1通目の本文', '2通目の本文'] assert hoge(messages) == 0 # 1回目は'1通目の本文'、2回目は'2通目の本文'がパラメーターで渡されて呼び出されていることが検証できます mailer_mock.assert_has_calls([call('1通目の本文'), call('2通目の本文')])戻り値を制御したい

test_hoge.pyfrom hoge import hoge from mailer import Mailer from unittest.mock import call def test_hoge(mocker): # side_effectに配列で戻り値のリストを渡します # 呼び出されるごとに配列の先頭から順番に返却されます # この例の場合、1回目はFalse、2回目はTrueが返却されます mailer_mock = mocker.patch.object(Mailer, 'send', side_effect = [False, True]) messages = ['1通目の本文', '2通目の本文'] # 2回めのMailer.sendがTrueを返却するので戻り値1の検証ができます assert hoge(messages) == 1例外を発生させたい

test_hoge.pyfrom hoge import hoge from mailer import Mailer from unittest.mock import call def test_hoge(mocker): # side_effectに例外を指定します # この例の場合、1回目はFalse、2回目は例外が発生します mailer_mock = mocker.patch.object(Mailer, 'send', side_effect = [False, Exception('error')]) messages = ['1通目の本文', '2通目の本文'] # 2回めのMailer.sendが例外が発生するので戻り値2の検証ができます assert hoge(messages) == 2

- 投稿日:2020-10-21T21:24:01+09:00

区間推定を行ってみた。

区間推定

今回は前回に引き続き推定を行っていきたいと思います。

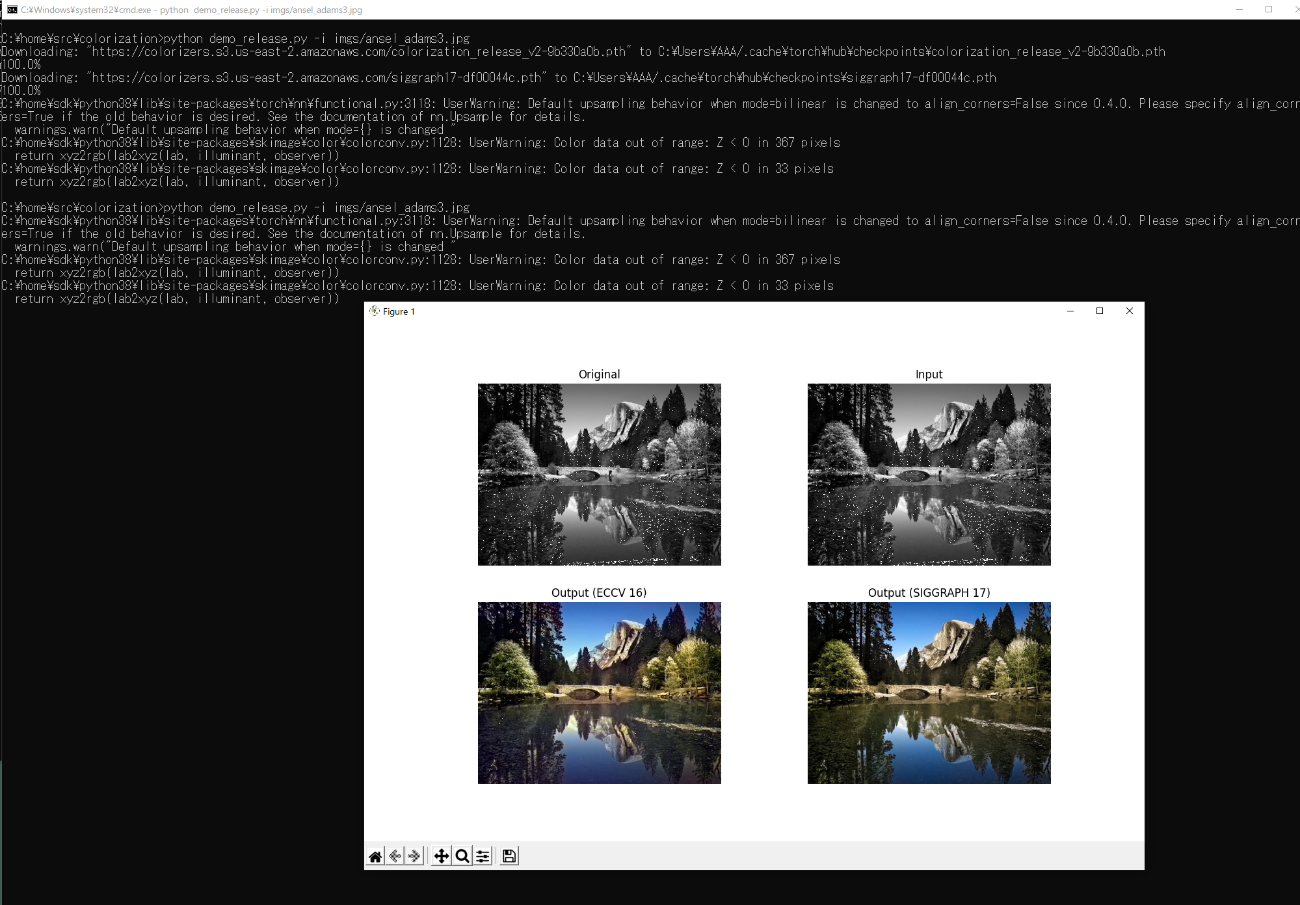

前回は点推定を行いましたので気になる方は見てみてください。データに関して

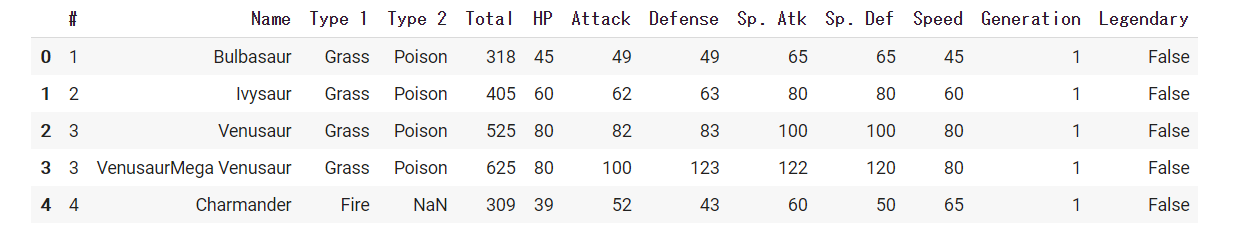

今回もPokemonのデータセットを使用して区間推定を行ってみました。

データは下のようになっています。

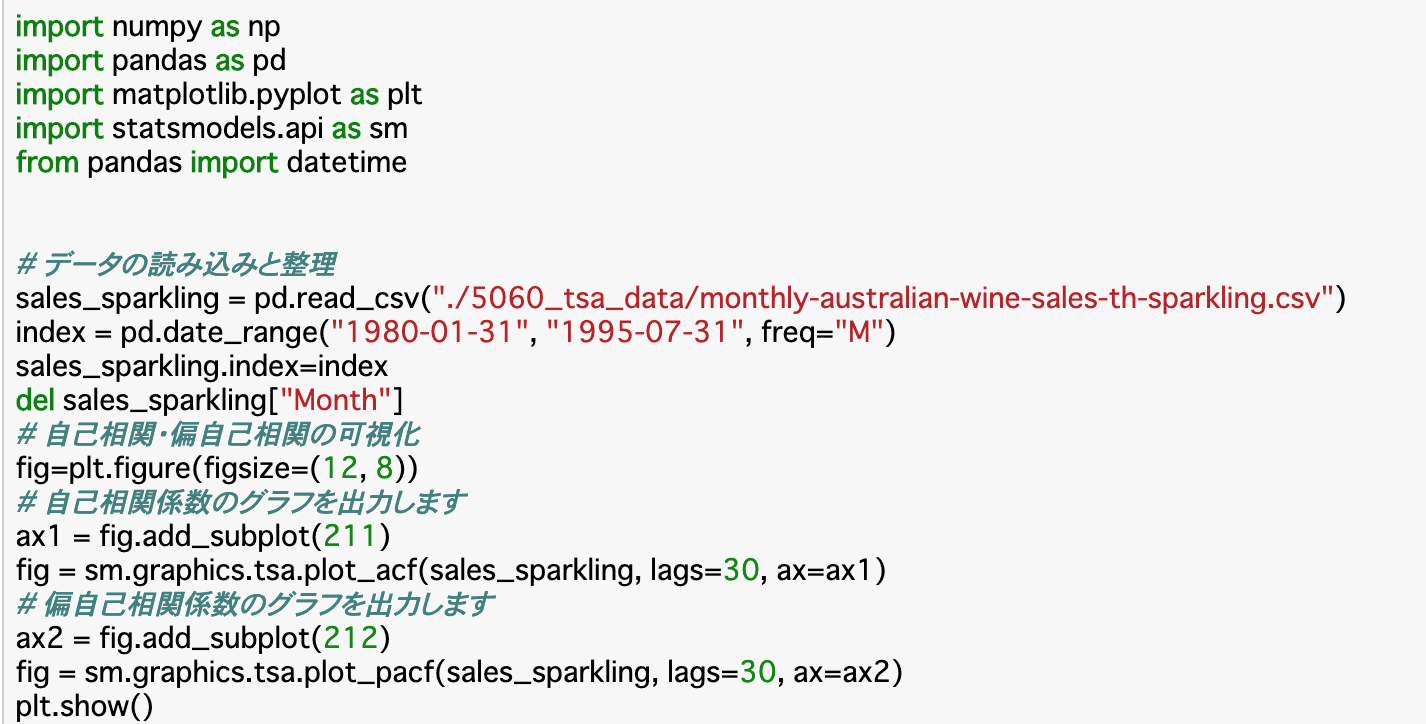

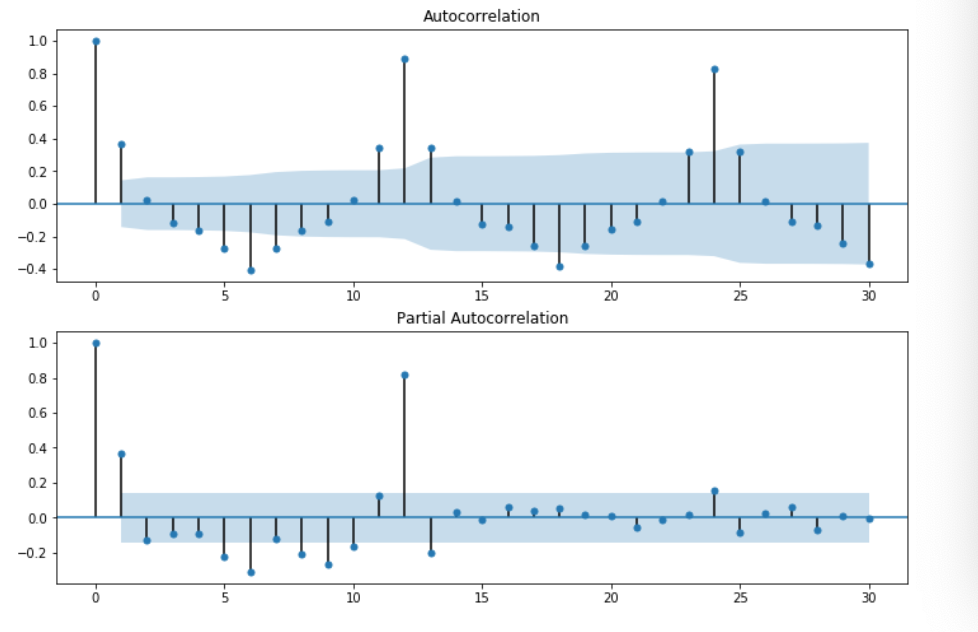

今回もこのデータのHPのデータをを母集団として区間推定を行っていきたいと思います。まずHPの平均と分散を求めてみたいと思います。

score = np.array(df['HP']) mean = np.mean(score) var = np.var(score) print("HP 平均: {} , 分散: {} ".format(mean , var))HP 平均: 69.25875 , 分散: 651.2042984374999

これらを母平均・母分散として分析を行っていきたいと思います。正規分布の母平均の区間推定(母分散が分かっている場合)

今回先ほどのHPデータを母集団とし、それが正規分布に従っていると仮定したうえでさらに母分散も分かっている場合を考えていきます。

母集団に正規分布を仮定しているため、標本平均$\bar{X}$は$N(μ,σ^2/n)$に従います。

つまり、標本平均という推定量は期待値は母平均μであるものの、標準偏差$\sqrt{σ^2/n}$でばらついている。このような推定量の標準偏差のことを「標準誤差」といいます。また標本平均$\bar{X}$は$N(μ,σ^2/n)$に従っていることから、$Z = (\bar{X}-μ)/\sqrt{σ^2/n}$と標準化を行うことができ、Zは標準正規分布に従います。この標準化を行うことで何がいいのかというと信頼区間を

計算することが容易に出来るようになるということです。まず母平均・母分散と標本データの標本平均・標本分散を計算します。

今回の標本のサンプルサイズは20にしています。np.random.seed(0) n = 20 sample = np.random.choice(score , n) p_mean = np.mean(score) p_var = np.var(score) s_mean = np.mean(sample) s_var = np.var(sample , ddof = 1)母平均: 69.25875 , 母分散: 651.2042984374999

標本平均: 68.8 , 標本分散(不偏分散): 451.26000000000005今回はこの標本平均を使用して母平均の信頼区間を算出してみたいと思います。(母分散はわかっているとします。)

標本平均から母平均の95%の信頼区間を求めることを考えます。まず標本平均$\bar{X}$を標準化すると$Z = (\bar{X}-μ)/\sqrt{σ^2/n}$となります。そのためまずは$Z$の95%信頼区間を考えてみます。

すると

$P(z_{0.975}≦(\bar{X}-μ)/\sqrt{σ^2/n} ≦z_{0.025})=0.95…①$

という不等式を立てることが出来ます。

この式は確率変数$Z = (\bar{X}-μ)/\sqrt{σ^2/n}$が区間$[z_{0.975},z_{0.025}]$に入る確率が95%であることを表しています。

この$①$の式を母平均のμについての不等式になるように変形すると

$P( \bar{X}-z_{0.025}*\sqrt{σ^2/n}≦μ≦\bar{X}-z_{0.095} * \sqrt{σ^2/n})=0.95$

となります。よって、母分散が分かっているときの95%の信頼区間を求めるには、

$[\bar{X}-z_{0.025}*\sqrt{σ^2/n} , \bar{X}-z_{0.095} * \sqrt{σ^2/n}]$

を求めればよいということになります。実装してみました。

rv = stats.norm() #rv.isf(0.025)には標準正規分布の確率が0.025の点を表している。それに標準誤差を掛ける。 lcl = s_mean - rv.isf(0.025) * np.sqrt(p_var/n) ucl = s_mean - rv.isf(0.975) * np.sqrt(p_var/n) lcl , ucl(57.616, 79.984)

以上より、母平均の95%信頼区間は(57.616, 79.984)であると分かりました。

先程求めた母平均は69.25875でしたので信頼区間内に母平均が含まれていることが分かります。この信頼区間は同じように何回も標本抽出を行い、区間推定を行うとそのうち95%の区間推定には母平均が含まれるということになります。かみ砕いた形で言ってみると、100回区間推定を行った場合、そのうちの95回は母平均を含む信頼区間が求まるけど、5回は求めた信頼区間に母平均が含まないといったことです。

母分散の区間推定

母分散の区間推定を行っていきます。ここでは母集団に正規分布を仮定し母平均も分かっていない場合を考えてみます。

先程、母平均の信頼区間を算出する際に標準化を行い、標準正規分布に従う確率変数に変換したように、不偏分散$s^2$も何らかの変換を行い代表的な確率分布に従う確率変数を作成する必要があります。

この時に使用される確率分布がカイ二乗分布になります。

不偏分散$s^2$に対して$Y=(n-1)s^2/σ^2$へ変換することでこの変数Yは自由度n-1のカイ二乗分布に従うことが知られています。では母分散の信頼区間を求めていきたいと思います。まず$\chi{}^2(n-1) $の95%信頼区間を求めていきます。

$P(\chi{}^2_{0.975}(n-1) ≦ (n-1)s^2/σ^2 ≦\chi{}^2_{0.025}(n-1)) = 0.95$

これを今回母分散の信頼区間を求めたいので$σ^2$が真ん中に来るようにします。

$P((n-1)s^2/\chi{}^2_{0.025}(n-1) ≦ σ^2 ≦(n-1)s^2/\chi{}^2_{0.975}(n-1)) = 0.95$

これより、母分散$σ^2$の95%信頼区間は

$[(n-1)s^2/\chi{}^2_{0.025}(n-1) , (n-1)s^2/\chi{}^2_{0.975}(n-1)]$

になります。

rv = stats.chi2(df=n-1) lcl = (n-1) * s_var / rv.isf(0.025) hcl = (n-1) * s_var / rv.isf(0.975) lcl , hcl(260.984, 962.659)

母分散の信頼区間は(260.984, 962.659)となりました。母分散は651.204であったので区間内に含まれていることが分かります。

母平均の区間推定(母分散が分かっていない場合)

先程母平均の信頼区間を求める際に母分散が分かっているという状況で分析を進めました。しかしながら実際母平均が分からず、母分散が分かっているという状況はあまりありません。

そのため、今回は母分散が分からないときの母平均の信頼区間の推定を行っていきたいと思います。母分散が分かっているときは、標本平均$\bar{X}$の標準誤差$\sqrt{σ^2/n}$によって区間推定を行いました。今回はこの母分散$σ^2$が分からないため、その代わりに推定量である不偏分散$s^2$を使用した$\sqrt{s^2/n}$を標準誤差として代用します。

まず、母分散が分かっているときと同じように標本平均$\bar{X}$を$\sqrt{s^2/n}$を使用して変換を行います。

$t = (\bar{X} - μ) / \sqrt{s^2/n}$

この$t$は

$Y=(n-1)s^2/σ^2$

$Z = (\bar{X}-μ)/\sqrt{σ^2/n}$この二つを使用して変換を行うと、

$t = Z / \sqrt{Y/(n-1)}$

で表すことが出来ます。

よってこの$t$は自由度n-1のt分布に従うことが分かります。今$t = (\bar{X} - μ) / \sqrt{s^2/n}$は自由度n-1のt分布に従うことが分かったので、ここから母平均の95%信頼区間を求めていきます。

$P(t_{0.975}(n-1)≦ (\bar{X} - μ) / \sqrt{s^2/n} ≦ t_{0.025}(n-1)) = 0.95$

この式を母平均のμが真ん中になるように変形します。

$P(\bar{X} - t_{0.025}(n-1) * \sqrt{s^2/n}≦ μ ≦ \bar{X} - t_{0.975}(n-1)*\sqrt{s^2/n}) = 0.95$

これにより、母平均の95%信頼区間は

$[ \bar{X} - t_{0.025}(n-1) * \sqrt{s^2/n} , \bar{X} - t_{0.975}(n-1)*\sqrt{s^2/n} ]$

となります。

rv = stats.t(df=n-1) lcl = s_mean - rv.isf(0.025) * np.sqrt(s_var/n) ucl = s_mean - rv.isf(0.975) * np.sqrt(s_var/n) lcl , ucl(58.858, 78.742)

母平均の95%信頼区間は(57.616, 79.984)であると分かりました。

先程求めた母平均は69.25875でしたので信頼区間内に母平均が含まれていることが分かります。まとめ

今回は区間推定を行ってみました。

実際に手を動かして実装を行うことによって理解が深まったりするので手を動かしてアウトプットするのはいいなと記事を書いてて思いました!<参考資料>

pythonで理解する統計解析の基礎

- 投稿日:2020-10-21T20:43:58+09:00

DockerでSparkを動かしたらlocalhost:4040にアクセスできない件について

Sparkの

Spark Web UI(localhost:4040)だけが何故か接続できなかったので、色々調べていたのですが解決策が乗っておらず、慣れていない人であれば同じ悩みを抱えている人がいると思ったので、初投稿します。また業務中に起きたエラーのため、コードなどは一切載せていませんのでご理解のほどよろしくお願いいたします。環境

DockerでPythonのコンテナとSparkのコンテナ(wokerを接続している)をBridgeしている

どちらの環境にもPyspark、javaの環境がインストールされている。環境構築の参考

SparkのMaster1つとWorker1つをdocker-composeで上げてpysparkを動かすまで

https://qiita.com/hrkt/items/fe9b1162f7a08a07e812ゴール

PythonのDockerの中に入って(docker exec...) spark-submitを行い、処理を行っている間にlocalhost:4040に接続してWebUIを確認したい。

問題について

起動してからlocalhost:8080はつながるのになぜか4040は接続ができない

解決策

- Sparkが処理中時にのみlocalhost:4040にアクセスできる

- docker-compose.ymlのSparkのコンテナにport 4040:4040と書いていたが、Job管理をするPython側にport 4040:4040を書く必要があった。(今回はこれが該当)

まとめ

StackOverFlowなどを読んでも全く分からなかったが、先輩に聞いたら一発で解決した。インフラにもっと強くなりたいです。

おまけ

sparkの中でサンプルコードを動かしていたが、

df.show()すると

initial job has not accepted any resources; check your cluster ui to ensure that workers are registered and have sufficient resourcesと出て止まってしまう。リソースが足りないとのことで、メモリ設定などを変えたが解決しなかった。サンプルコードはこちらから借りてきました。

PySpark のスクリプトファイルで引数を扱う

https://blog.amedama.jp/entry/2018/03/17/113516参考にしたサンプルコード

from pyspark import SparkConf from pyspark import SparkContext from pyspark.sql import SparkSession def main(): conf = SparkConf() conf.setAppName('example') sc = SparkContext(conf=conf) spark = SparkSession(sc) df = spark.sql('SELECT "Hello, World!" AS message') df.show()解決策

conf = SparkConf().setMaster('local')

- 投稿日:2020-10-21T20:38:07+09:00

MySQL初心者の私がよく書き込みでハマるポイント

pythonからMySQLに書き込みを行う時、いつもハマる。

今回こそハマりどころメモしておく。実施内容のイメージ

Pythonを使ってローカルのcsvをローカルにたてたMySQLやGoogle Cloud PLatformのMySQLにデータを書き込む。

環境

Python3

mysql-connector

GCPのCloud SQL(MySQL)(今回は)

接続方法やSSL化については今回は省略。純粋にSQL文のハマりどころについてです。書き込む際のコード

main.py# -*- coding: utf-8 -*- import os import sys import time import glob import shutil import datetime import logging import traceback import pandas as pd import mysql.connector import ssl ssl.match_hostname = lambda cert, hostname: True def insert_sql(): schema = 'hogehoge2'#db名のこと connection = mysql.connector.connect( port="3306",#基本はこのポートを使うことが多い host='**.**.**.**',#gcpのIP user='hogehoge', password='fugafuda', db=schema, charset='utf8', ssl_ca="./cloudstorage_cert/server-ca.pem",#証明書を使いたいので今回はこのフォルダにおいて指定 ssl_cert="./cloudstorage_cert/client-cert.pem", ssl_key="./cloudstorage_cert/client-key.pem" ) df = pd.read_csv(filename,engine="python") for r in range(df.shape[0]): cur = connection.cursor() sql = "insert into schema.table (col1,col2,col3,col4) values ('%s','%s',%s,%s);"%( datetime.datetime.now(), str(datetime.datetime.now()), 100, 1.5 ) print(sql) cur.execute(sql) cur.close() connection.commit() connection.close() print("done") if __name__ == '__main__': insert_sql()注意ポイント

1.テーブルを指定するとき、ちゃんとスキーマ(db)を記載する

my.sqlダメな例 insert into mytable (datetime,col2,col3,col4) values ('2020-10-20 10:39:13.252105','2020-10-20 10:39:13.252105',100,1.5); いい例 insert into myshema.mytable (datetime,col2,col3,col4) values ('2020-10-20 10:39:13.252105','2020-10-20 10:39:13.252105',100,1.5);2. 文字列や時間など数字ではないものは、SQL文の中でシングルクオートで囲む

example.py#ダメな例 sql = "insert into myshema.mytable (datetime,col2,col3,col4) values (%s,%s,%s,%s);"%( temp.loc[r,"DateTime"], str(temp.loc[r,"DateTime"]), 100, 1.5 ) #いい例 sql = "insert into myshema.mytable (datetime,col2,col3,col4) values ('%s','%s',%s,%s);"%( temp.loc[r,"DateTime"], str(temp.loc[r,"DateTime"]), 100, 1.5 )3. connectionに対してcommit()しないとデータが反映されない

connection.close()は忘れないのだが、connection.commit()を忘れてデータが更新されないことがある。cur.commit()はしない。connectionでcommit()することに注意。

以上のあたりでよくハマる。sql文の最後の;はあってもなくても動作した

- 投稿日:2020-10-21T20:18:30+09:00

全プログラミング言語の用語整理

言語自体の整理

1. 動的型付けのプログラミング言語

プログラムでは様々な「型」を扱います。例えば、文字列値と整数値と少数値は異なる型です。この他にも様々な型があり、プログラムにミスがあって異なった型を指定しまう事でエラーを発生させることがあります。

動的型付けのプログラミング言語の場合はプログラムを実行時に型検査を行います。厳格なエラーを対処しなくてもプログラムは動作するので初心者には学びやすい言語が多くなっています。しかしその反面、非常に分かりにくい不具合を作り込んでしまう可能性もあります。

言語名 F-S Initial release 起源 JavaScript FS HTML と合わせて使用して動きのある WEB ページを開発するために使用 1995 Ruby FS 日本人により開発された。可読性を重視した構文 1995 Python FS 最近ではAI やデータ解析処理の場面において利用されおり注目度の高い言語 1990 PHP S 動的な WEB サイトを実装する為の言語であるため、ライブラリを用いなくても WEB アプリケーション向けの処理が実装 1995 2. 静的型付けのプログラミング言語

動的型付けのプログラミング言語の場合、「コンパイル」を行う事でプログラミング時に型チェックを行います。静的型付けのプログラミング言語に比べて型チェックが厳格になっているので実装する処理も多くなります。

静的型付けのプログラミング言語に比べて難易度は高いと言えます。

言語名 F-S Initial release 起源 C - 高速に動作。システムの共通言語として様々なplatformで使用。garbage collection等、最近の機能は実装されてなく習得難易度はとても高い 1972 C++ - C を元にオブジェクト指向や例外処理等の概念を取り入れた言語 1993-2 C# - Microsoft が開発した .Net Framework と言うプラットフォーム上で動作させるためのプログラム 2000 Objective-C / Swift - Apple 社の MacOS や iOS 用のアプリケーションを開発するためのプログラム言語 1984/2014-6 SQL - データベースから情報の取得、追加、更新、削除と言った処理を行う為の言語 1974 各言語詳細

1. フロントエンド

Js (npmやYarn パッケージ管理) ーVue Initial release February 2014; ーーnuxt VueのFramework Initial release October 26, 2016; ーーーVuexなどのライブラリ ーReact Initial release May 29, 2013; ーーNext ReactのFramework ーーーReduxなどのライブラリ ーーーMaterial UI Reactのcomponents、Vuetifyみたいな感じか react native Initial-March 26, 2015 angular Initial release 2.0 / 14 September 2016;Python First appeared 1990; (pip パッケージ管理) ーDjango Python-web-framework Initial releas21 July 2005Ruby 1995 (gem パッケージ管理) ーーrails August 2004;2. サーバーエンド

PHP (composer パッケージ管理) ーLaravel PHPのFramework Initial release June 2011JavaScript Node Initial release May 27, 2009; Node express November 16, 2010;

- 投稿日:2020-10-21T19:49:25+09:00

Dlibを使って顔の輪郭をとる(1)

やること

DlibとPythonを使って、顔の輪郭や口の動きをとるフェイストラッキングを実行します。

PC(ここではMac)のWEBカメラで取得したものに即座に反映、表示します。

この記事は2017年に公開いただいているのQiita記事を今トレースする場合の備忘メモです。過去のQiita記事に答えがあるので参考にします

Qiita記事:dlibの顔ランドマーク認識の結果をリアルタイムにmatplotlibで表示する

基本は上記に沿ってありがたく実行させていただくだけですが、ちょっとだけ変更があります。

変更箇所

データファイルの参照先URLが変更になっているので、別途DLして実行します。

https://www.kkaneko.jp/dblab/dlib/dlibface.html

こちらを参考に、http://dlib.net/files/

こちらを開いて、「shape_predictor_68_face_landmarks.dat.bz2」をDLし展開します。前述のプログラムの中の

pythonpredictor_path = "hoge"のhogeのところにさきほどのファイルを絶対パスで指定すれば安心です。

実行結果

PCのカメラにお札を見せているところです。もちろん実写の顔もちゃんととれます。

次回

もうちょっと早く認識&表示できてなおかつ勘弁な方法があれば試したいです。

表情判定もやっておきたいです。

- 投稿日:2020-10-21T19:43:41+09:00

PyMuPDFで「exception stack overflow!」

はじめに

備忘録としてのメモ。

ググっても答えに辿り着けなかったので、念のため残しておく。問題点

PyMuPDF を使って PDF のコピーをするときに、まれに

exception stack overflow!が発生することがある。

- コード

new_doc = fitz.open() new_doc.insertPDF(docsrc=old_doc, from_page=1, to_page=1)

- エラー

mupdf: exception stack overflow! Traceback (most recent call last): File "<stdin>", line 1, in <module> ・ ・ ・ File "/Users/ijufumi/workspaces/python_sample/.venv/lib/python3.6/site-packages/fitz/fitz.py", line 3581, in insertPDF val = _fitz.Document_insertPDF(self, docsrc, from_page, to_page, start_at, rotate, links, annots) RuntimeError: exception stack overflow!対応策

insertPDFを実行する時に、annots=Falseを指定する。

- コード(修正後)

new_doc = fitz.open() new_doc.insertPDF(docsrc=old_doc, from_page=1, to_page=1, annots=False)原因

公式ドキュメントでは見つけられなかったけど、いくつかのアノテーションがあるとこの例外が発生する。

お願い

もし、公式ドキュメントなどで見つけた人がいましたら、コメント頂けると幸いです。

- 投稿日:2020-10-21T18:36:49+09:00

Scikit-learn の impute で欠損値を埋める

Scikit-learn の impute は、機械学習の前処理として欠損データを埋めるのに使われます。簡単なデータを利用して挙動を確認してみました。

テスト用データ作成

data = { 'A': [a for a in range(10)], 'B': [a * 2 for a in range(10)], 'C': [a * 3 for a in range(10)], 'D': [a * 4 for a in range(10)], }import pandas as pd data = pd.DataFrame(data) data

A B C D 0 0 0 0 0 1 1 2 3 4 2 2 4 6 8 3 3 6 9 12 4 4 8 12 16 5 5 10 15 20 6 6 12 18 24 7 7 14 21 28 8 8 16 24 32 9 9 18 27 36 import numpy as nan data2 = pd.DataFrame(data) #data2['B'][3] = np.nan data2.loc.__setitem__(((2), ("B")), np.nan) data2.loc.__setitem__(((3), ("C")), np.nan) data2.loc.__setitem__(((5), ("C")), np.nan) data2.loc.__setitem__(((6), ("D")), np.nan) data2.loc.__setitem__(((7), ("D")), np.nan) data2

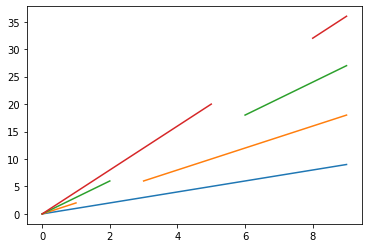

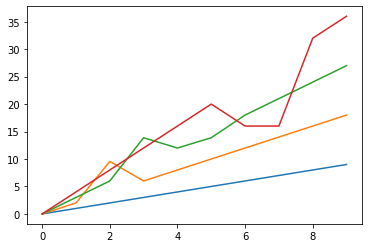

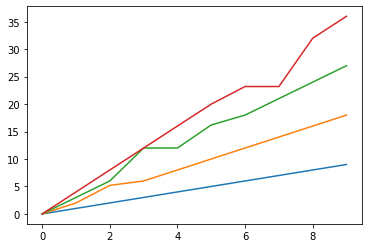

A B C D 0 0 0.0 0.0 0.0 1 1 2.0 3.0 4.0 2 2 NaN 6.0 8.0 3 3 6.0 NaN 12.0 4 4 8.0 12.0 16.0 5 5 10.0 NaN 20.0 6 6 12.0 18.0 NaN 7 7 14.0 21.0 NaN 8 8 16.0 24.0 32.0 9 9 18.0 27.0 36.0 %matplotlib inline import matplotlib.pyplot as plt plt.plot(data2)[<matplotlib.lines.Line2D at 0x7fdb46668c18>, <matplotlib.lines.Line2D at 0x7fdb46668d30>, <matplotlib.lines.Line2D at 0x7fdb46668e80>, <matplotlib.lines.Line2D at 0x7fdb46668fd0>]以上のようにして、欠損値を1つ含むB列、2つ含むC列、連続した欠損値を含むD列を作成しました。

SimpleImputer

SimpleImputerクラスは、欠損値を入力するための基本的な計算法を提供します。欠損値は、指定された定数値を用いて、あるいは欠損値が存在する各列の統計量(平均値、中央値、または最も頻繁に発生する値)を用いて計算することができます。

default(mean)

デフォルトは平均値で埋めます。

from sklearn.impute import SimpleImputer imp = SimpleImputer() #missing_values=np.nan, strategy='mean') data3 = pd.DataFrame(imp.fit_transform(data2)) data3

0 1 2 3 0 0.0 0.000000 0.000 0.0 1 1.0 2.000000 3.000 4.0 2 2.0 9.555556 6.000 8.0 3 3.0 6.000000 13.875 12.0 4 4.0 8.000000 12.000 16.0 5 5.0 10.000000 13.875 20.0 6 6.0 12.000000 18.000 16.0 7 7.0 14.000000 21.000 16.0 8 8.0 16.000000 24.000 32.0 9 9.0 18.000000 27.000 36.0 %matplotlib inline import matplotlib.pyplot as plt plt.plot(data3)[<matplotlib.lines.Line2D at 0x7fdb465dd2b0>, <matplotlib.lines.Line2D at 0x7fdb465dd3c8>, <matplotlib.lines.Line2D at 0x7fdb465dd518>, <matplotlib.lines.Line2D at 0x7fdb465dd668>]以上のように、データの種類によっては、平均値で埋めるのは不自然になったりしますね。

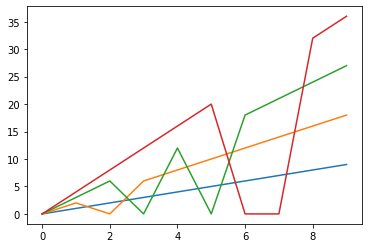

median

欠損値を中央値で埋めることもできます。

from sklearn.impute import SimpleImputer imp = SimpleImputer(missing_values=np.nan, strategy='median') data4 = pd.DataFrame(imp.fit_transform(data2)) data4

0 1 2 3 0 0.0 0.0 0.0 0.0 1 1.0 2.0 3.0 4.0 2 2.0 10.0 6.0 8.0 3 3.0 6.0 15.0 12.0 4 4.0 8.0 12.0 16.0 5 5.0 10.0 15.0 20.0 6 6.0 12.0 18.0 14.0 7 7.0 14.0 21.0 14.0 8 8.0 16.0 24.0 32.0 9 9.0 18.0 27.0 36.0 %matplotlib inline import matplotlib.pyplot as plt plt.plot(data4)[<matplotlib.lines.Line2D at 0x7fdb465310b8>, <matplotlib.lines.Line2D at 0x7fdb465311d0>, <matplotlib.lines.Line2D at 0x7fdb46531320>, <matplotlib.lines.Line2D at 0x7fdb46531470>]平均値と同様、中央値で埋める場合も、データの内容によっては不自然な埋め型になってしまうことがありますね。

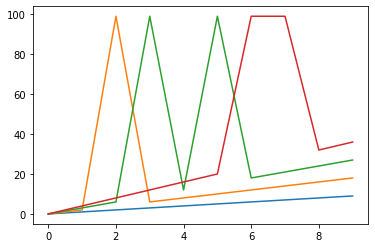

most_frequent

最頻値で埋めることもできます。

from sklearn.impute import SimpleImputer imp = SimpleImputer(missing_values=np.nan, strategy='most_frequent') data5 = pd.DataFrame(imp.fit_transform(data2)) data5

0 1 2 3 0 0.0 0.0 0.0 0.0 1 1.0 2.0 3.0 4.0 2 2.0 0.0 6.0 8.0 3 3.0 6.0 0.0 12.0 4 4.0 8.0 12.0 16.0 5 5.0 10.0 0.0 20.0 6 6.0 12.0 18.0 0.0 7 7.0 14.0 21.0 0.0 8 8.0 16.0 24.0 32.0 9 9.0 18.0 27.0 36.0 %matplotlib inline import matplotlib.pyplot as plt plt.plot(data5)[<matplotlib.lines.Line2D at 0x7fdb46495898>, <matplotlib.lines.Line2D at 0x7fdb464959b0>, <matplotlib.lines.Line2D at 0x7fdb46495b00>, <matplotlib.lines.Line2D at 0x7fdb46495c50>]最頻値がない場合は最初の値で埋めるようですね。

constant

あらかじめ決まった数値を設定してそれで埋めることもできます。

from sklearn.impute import SimpleImputer imp = SimpleImputer(missing_values=np.nan, strategy='constant', fill_value=99) data6 = pd.DataFrame(imp.fit_transform(data2)) data6

0 1 2 3 0 0.0 0.0 0.0 0.0 1 1.0 2.0 3.0 4.0 2 2.0 99.0 6.0 8.0 3 3.0 6.0 99.0 12.0 4 4.0 8.0 12.0 16.0 5 5.0 10.0 99.0 20.0 6 6.0 12.0 18.0 99.0 7 7.0 14.0 21.0 99.0 8 8.0 16.0 24.0 32.0 9 9.0 18.0 27.0 36.0 %matplotlib inline import matplotlib.pyplot as plt plt.plot(data6)[<matplotlib.lines.Line2D at 0x7fdb464890b8>, <matplotlib.lines.Line2D at 0x7fdb464891d0>, <matplotlib.lines.Line2D at 0x7fdb46489320>, <matplotlib.lines.Line2D at 0x7fdb46489470>]まあ、なんて不自然なんでしょ。

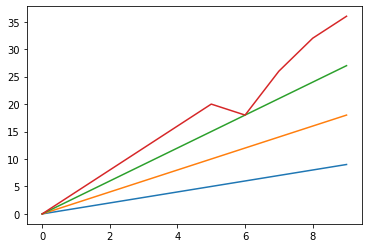

KNNImputer

KNNImputerクラスは、k-Nearest Neighborsアプローチを使用して欠損値を埋めます。デフォルトでは、欠落値をサポートするユークリッド距離メトリックであるnan_euclidean_distancesが、最近傍を見つけるために使用されます。隣人の特徴は,一様に平均化されるか,各隣人までの距離によって重み付けされます.サンプルに1つ以上の特徴が欠落している場合,そのサンプルの隣人は,入力される特定の特徴に応じて異なることがあります.利用可能な隣人の数がn_neighborsよりも少なく、訓練セットへの定義された距離がない場合、その特徴の訓練セット平均が入力中に使用されます。定義された距離を持つ隣人が少なくとも1つある場合、残りの隣人の加重平均または非加重平均が入力時に使用されます。

n_neighbors=2

考慮に入れる隣人の数を明示的に n_neighbors=2 にしてみましょう。

from sklearn.impute import KNNImputer imputer = KNNImputer(n_neighbors=2) data7 = pd.DataFrame(imputer.fit_transform(data2)) data7

0 1 2 3 0 0.0 0.0 0.0 0.0 1 1.0 2.0 3.0 4.0 2 2.0 4.0 6.0 8.0 3 3.0 6.0 9.0 12.0 4 4.0 8.0 12.0 16.0 5 5.0 10.0 15.0 20.0 6 6.0 12.0 18.0 18.0 7 7.0 14.0 21.0 26.0 8 8.0 16.0 24.0 32.0 9 9.0 18.0 27.0 36.0 %matplotlib inline import matplotlib.pyplot as plt plt.plot(data7)[<matplotlib.lines.Line2D at 0x7fdb46246ef0>, <matplotlib.lines.Line2D at 0x7fdb461d3048>, <matplotlib.lines.Line2D at 0x7fdb461d3198>, <matplotlib.lines.Line2D at 0x7fdb461d32e8>]2連続で欠損しているような場合、うまく埋められないようですね。

default(n_neighbors=5)

デフォルトでは隣人を5人まで考慮するようです。

from sklearn.impute import KNNImputer imputer = KNNImputer() data8 = pd.DataFrame(imputer.fit_transform(data2)) data8

0 1 2 3 0 0.0 0.0 0.0 0.0 1 1.0 2.0 3.0 4.0 2 2.0 5.2 6.0 8.0 3 3.0 6.0 12.0 12.0 4 4.0 8.0 12.0 16.0 5 5.0 10.0 16.2 20.0 6 6.0 12.0 18.0 23.2 7 7.0 14.0 21.0 23.2 8 8.0 16.0 24.0 32.0 9 9.0 18.0 27.0 36.0 %matplotlib inline import matplotlib.pyplot as plt plt.plot(data8)[<matplotlib.lines.Line2D at 0x7fdb461b86a0>, <matplotlib.lines.Line2D at 0x7fdb461b87b8>, <matplotlib.lines.Line2D at 0x7fdb461b8908>, <matplotlib.lines.Line2D at 0x7fdb461b8a58>]D列の埋め方は比較的マシになりましたが、その代わりB列C列の埋め方に少し悪影響が出ましたね。

まとめ

欠損値の埋め方に完璧な方法はたぶん存在しないので、データの特徴をよく考えながら、準最適な方法を選びましょう!

- 投稿日:2020-10-21T17:46:07+09:00

Django ForeignKeyのon_deleteの引数

参考

ForeignKeyのon_deleteについて

models.py# サンプルのモデル class Book(AbstractModel): publisher = models.ForeignKey(Publisher, on_delete=models.CASCADE)models.CASCADE

参照しているオブジェクト(例: Publisher)が削除されたら

一緒にオブジェクト(例: Book)を削除する

例: ブログの記事を消したらそこに寄せられたコメントも必要ないから消すmodels.PROTECT

参照しているオブジェクト(例: Publisher)が削除されても

オブジェクト(例: Book)は削除しない

全てのオブジェクトを削除したいなら全部手動でやらなきゃならない。models.SET_NULL

参照しているオブジェクト(例: Publisher)が削除されたら

オブジェクト(例: Book)にはNULL(例: establishmentにNULL)がセットされる

例: ユーザを削除するとき、ブログにユーザが寄せたコメントだけは匿名で残したいときなんかはこれが使える。

※null=Trueにする必要あり。models.SET_DEFAULT

参照しているオブジェクト(例: Publisher)が削除されたら

オブジェクト(例: Book)にはdefaultで設定した値(例: establishmentにdefault)がセットされるmodels.pypublisher = models.ForeignKey(Publisher, on_delete=models.SET_DEFAULT, default='不明')models.SET

独自で設定した値を代入する。

callableを渡す。models.pydef get_publisher(): # とりあえず一つ目返す return Publisher.objects.all().first() class Book(AbstractModel): publisher = models.ForeignKey(Publisher, on_delete=models.SET(get_publisher))models.RESTRICT

※これはDjango3.1の機能です。

オブジェクトを削除する際に

参照しているオブジェクトが存在すると、削除せずにRestrictedErrorとする。models.pyclass Artist(models.Model): name = models.CharField(max_length=10) class Album(models.Model): artist = models.ForeignKey(Artist, on_delete=models.CASCADE) class Song(models.Model): artist = models.ForeignKey(Artist, on_delete=models.CASCADE) album = models.ForeignKey(Album, on_delete=models.RESTRICT)consoleartist_one = Artist.objects.create(name='artist one') album_one = Album.objects.create(artist=artist_one) song_one = Song.objects.create(artist=artist_one, album=album_one) album_one.delete() # Raises RestrictedError. # 参照しているsongが存在するためエラー artist_two = Artist.objects.create(name='artist two') album_two = Album.objects.create(artist=artist_two) song_two = Song.objects.create(artist=artist_one, album=album_two) # artist_oneを使っていることに注意 artist_two.delete() # Raises RestrictedError. # artist_twoを削除するとCASCADEしているalbumも削除されるため、 # 参照しているSongでエラーが発生する

- 投稿日:2020-10-21T16:40:13+09:00

Tonelli-Shanks アルゴリズムの理解と実装(2)

はじめに

前回の記事はこちらです。

実装

まず、今回仮定する条件をもう一度しておきます。

- Input:

- $p$ : 奇素数

- $n$ : 整数, ただし$n$は$p$の倍数ではない

- Output:

- $x$ : $x^2 \equiv n\ {\rm mod}\ p$, かつ $0 < x < n$を満たす1

$n$が$p$の倍数なら、$n \equiv 0\ {\rm mod}\ p$で剰余とは言いづらいので今回は除外します(例外としてコード中に組み込みます)。

Legendre記号

$$\left(\begin{array}

nn\\

p

\end{array}\right) := n^{\frac{p-1}{2}} \equiv \begin{cases}

1\ {\rm mod}\ p\Leftrightarrow n は平方剰余\\

-1\ {\rm mod}\ p \Leftrightarrow n は平方非剰余

\end{cases}$$でした。ここで、$n$が$p$の倍数なら当然

$$\left(\begin{array}

nn\\

p

\end{array}\right) = 0$$

となるので、ここで例外処理をしておきます。なお、

pow(a, b, c)は$a^b \ {\rm mod}\ c$を表します2。def legendre_symbol(n, p): ls = pow(n, (p - 1) // 2, p) if ls == 1: return 1 # pow関数は0 ~ p-1の範囲で値を返します elif ls == p - 1: return -1 else: # ls == 0、つまりnがpの倍数の場合 raise Exception('n:{} = 0 mod p:{}'.format(n, p))pが4で割って3余る素数の場合

$$x = \pm n^{\frac{p+1}{4}}$$

が答えでした。一応答えが正しいことを確認する

check_sqrt関数も定義しておきます。# 基本的にここでassertionエラーは出ないはず def check_sqrt(x, n, p): assert(pow(x, 2, p) == n % p) def modular_sqrt(n, p): if p % 4 == 3: x = pow(n, (p + 1) // 4, p) check_sqrt(x, n, p) return [x, p - x] else: # これから説明 passpが4で割って1余る素数の場合

ここからTonelli-Shanksのアルゴリズムの実装です。

Step 1.

$$p-1 = Q \cdot 2^S$$

という形に変形します($Q$は奇数で、$S$は正の整数です)。

Pythonでは多くの場合、大文字は定数を意味するので小文字の

q, sを使います。def modular_sqrt(n, p): ... else: # Step 1. q, s = p - 1, 0 while q % 2 == 0: q //= 2 s += 1 ...Step 2.

平方非剰余である$z$をランダムに選美ます。

前回も述べたように、半数は平方非剰余なので$2$から総当たりしています。

なぜ$1$から始めないのかというと、$x^2 \equiv 1\ {\rm mod} p$なる$x$は自明に存在($x=1$)して、任意の$p$に対して$1$は平方剰余だからです。

def modular_sqrt(n, p): ... else: # Step 1. q, s = p - 1, 0 while q % 2 == 0: q //= 2 s += 1 # Step 2. z = 2 while legendre_symbol(z, p) != -1: z += 1 ...Step 3.

$$\begin{cases}

M_0 = S\\

c_0 = z^Q\\

t_0 = n^Q\\

R_0 = n^{\frac{Q+1}{2}}

\end{cases}$$これはそのままです。先ほどと同様、すべて小文字で定義します。

def modular_sqrt(n, p): ... else: ... # Step 2. z = 2 while legendre_symbol(z, p) != -1: z += 1 # Step 3. m, c, t, r = s, pow(z, q, p), pow(n, q, p), pow(n, (q + 1) // 2, p) ...Step 4.

もし$t_i \equiv 1$なら、$\pm R_i$が$n$の平方根であり、ループ文を抜けて終了。

そうでない場合は、以下のように値を更新する。

$$\begin{cases}

M_{i+1} = \left(\left(t_i\right)^{2^{j}}\equiv 1 を満たす最小のj, ただし0 < j < M_i\right)\\

\\

c_{i+1} = \left(c_i\right)^{2^{M_i - M_{i+1}}}\\

\\

t_{i+1} = t_i \cdot \left(c_i\right)^{2^{M_i - M_{i+1}}}\\

\\

R_{i+1} = R_i \cdot \left(c_i\right)^{2^{M_i - M_{i+1}-1}}

\end{cases}$$さて、これを実装する上で、2つ補足説明をしておきます。

1つ目。

$M_{i+1}$を求める上で、$j = 1, 2, \cdots$と順に代入していく分けですが、「$t_i$を$2$回掛けて$(t_i)^2$を計算し、1になるか調べる。ならなければ$t_i$を$4$回掛けて$(t_i)^4$を計算し、1になるか調べる。…」とする以下のコードは少し無駄が多いと思いませんか?(

m_updateが$M_{i+1}$に相当します)for j in range(1, m): if pow(t, pow(2, j), p) == 1: m_update = j breakせっかく$(t_i)^2$を計算しているなら、それを2乗することで$(t_i)^4$が求められるので再利用しましょう3。

pow_t = pow(t, 2, p) for j in range(1, m): if pow_t == 1: m_update = j break pow_t = pow(pow_t, 2, p)2つ目。

$$b_i = \left(c_i\right)^{2^{M_i - M_{i+1}-1}}$$

と定義すると、値の更新は以下のようにすっきりと書けます。この記号はWikipediaにも記載されています。

$$\begin{cases}

M_{i+1} = \left(\left(t_i\right)^{2^{j}}\equiv 1 を満たす最小のj, ただし0 < j < M_i\right)\\

\\

c_{i+1} = b_i^2\\

\\

t_{i+1} = t_i \cdot b_i^2\\

\\

R_{i+1} = R_i \cdot b_i

\end{cases}$$前回はこれ以上変数を導入するとややこしいかなと思ったので割愛していました。

以上2点を踏まえて、以下のようにコードが書けます。

def modular_sqrt(n, p): ... else: ... # Step 3. m, c, t, r = s, pow(z, q, p), pow(n, q, p), pow(n, (q + 1) // 2, p) # Step 4. while t != 1: pow_t = pow(t, 2, p) for j in range(1, m): if pow_t == 1: m_update = j break pow_t = pow(pow_t, 2, p) b = pow(c, int(pow(2, m - m_update - 1)), p) m, c, t, r = m_update, pow(b, 2, p), t * pow(b, 2, p) % p, r * b % p # 答えの確認 check_sqrt(r, n, p) return [r, p - r]実装上の注意としては、$c_{i+1}, t_{i+1}, R_{i+1}$に更新する際に$M_i$と$M_{i+1}$の両方を用いるので、一旦

m_update = jとおいてmをすぐに更新しないことです。その他

$p$が素数であるかどうかの確認は実は多項式時間で可能です4。

from gmpy2 import is_prime is_prime(p)あるいは

from Crypto.Util.number import isPrime isPrime(p)で高速な素数判定が可能です。

どちらも標準では入っていないモジュールだと思うので、

pip3でインストールする必要があります。全体のソースコード

#!/usr/bin/env python3 from Crypto.Util.number import isPrime # from gmpy2 import is_prime def legendre_symbol(n, p): ls = pow(n, (p - 1) // 2, p) if ls == 1: return 1 elif ls == p - 1: return -1 else: # in case ls == 0 raise Exception('n:{} = 0 mod p:{}'.format(n, p)) def check_sqrt(x, n, p): assert(pow(x, 2, p) == n % p) def modular_sqrt(n:int, p:int) -> list: if type(n) != int or type(p) != int: raise TypeError('n and p must be integers') if p < 3: raise Exception('p must be equal to or more than 3') if not isPrime(p): raise Exception('p must be a prime number. {} is a composite number'.format(p)) if legendre_symbol(n, p) == -1: raise Exception('n={} is Quadratic Nonresidue modulo p={}'.format(n, p)) if p % 4 == 3: x = pow(n, (p + 1) // 4, p) check_sqrt(x, n, p) return [x, p - x] # Tonelli-Shanks q, s = p - 1, 0 while q % 2 == 0: q //= 2 s += 1 z = 2 while legendre_symbol(z, p) != -1: z += 1 m, c, t, r = s, pow(z, q, p), pow(n, q, p), pow(n, (q + 1) // 2, p) while t != 1: pow_t = pow(t, 2, p) for j in range(1, m): if pow_t == 1: m_update = j break pow_t = pow(pow_t, 2, p) b = pow(c, int(pow(2, m - m_update - 1)), p) m, c, t, r = m_update, pow(b, 2, p), t * pow(b, 2, p) % p, r * b % p check_sqrt(r, n, p) return [r, p - r] print(modular_sqrt(5, 41)) # => [28, 13]

$0 < x < p$で解が見つかれば、その$x$に対して$p$を順々に足して(あるいは引いて)いったものも当然解になるので、今回は$0 < x < p$の範囲に限定しました。 ↩

Pythonであれば

a ** b % cという書き方もできますが、pow関数を使った方がより高速に動作します。 ↩例えば、$0 < j < 10$なら、前者は

pow関数の呼び出しは最大18回ですが、後者は9回で済みます。すごくアバウトな計算量評価ですが、こういった観点から後者の方を今回採用しました。ただ、実際はどちらを使っても元々のアルゴリズムが高速なのでほぼ差は出ません。 ↩「$p$が素数でない(=合成数である)」と「$p$の素因数分解の結果が分かる」は別です。今回は前者について触れています。後者が多項式時間でできてしまうと、いわゆるRSA暗号などの安全性に対する理論が瓦解してしまいます。(かといって、多項式時間ではできないだろうと言われているだけで、まだ未解決の問題のままです。) ↩

- 投稿日:2020-10-21T16:39:44+09:00

Tonelli-Shanks アルゴリズムの理解と実装(1)

はじめに

奇素数$p$と$0$でない整数$n$が与えられた際に

$$ x^2 \equiv n\ {\rm mod}\ p$$

なる$x\not \equiv 0$が存在するならば、$n$は$p$を法として平方剰余(Quadratic Residue)であると言い、そのような$x$が存在しないならば$n$は平方非剰余(Quadratic Nonresidue)であると言います。

例えば、$n=2$は$p=7$を法として平方剰余($x=3$などが解)ですが、$n=3$は平方非剰余です。

さて、平方剰余かどうかの判定はそれほど難しくありません。

まずは、Legendre(ルジャンドル)記号を以下で定義します。

$$\left(\begin{array}

nn\\

p

\end{array}\right) := n^{\frac{p-1}{2}}$$この時、以下が成立します(証明は少し難しいのでここでは省略します)。

$$\left(\begin{array}

nn\\

p

\end{array}\right) \equiv \begin{cases}

1\ {\rm mod}\ p\Leftrightarrow n は平方剰余\\