- 投稿日:2020-09-16T23:31:08+09:00

intelijでファイル保存時にコマンドを実行する

blackとpylintを使った快適なPython開発

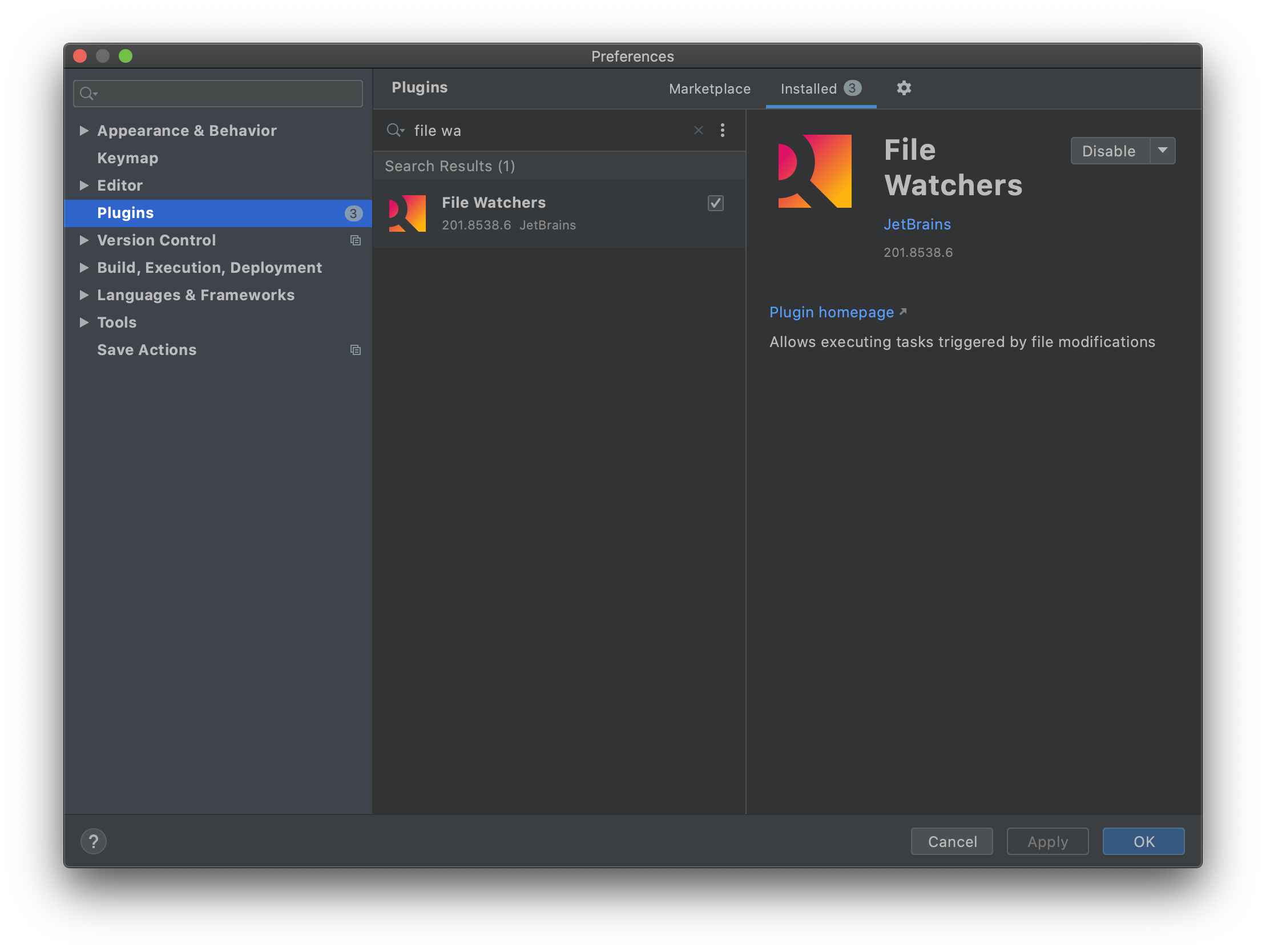

の補足みたいな記事です。File Watchersのインストール

Preferences > Plugins

からFile Watchersをインストールする(インストール後にintelijの再起動が必要)File Watchersの設定

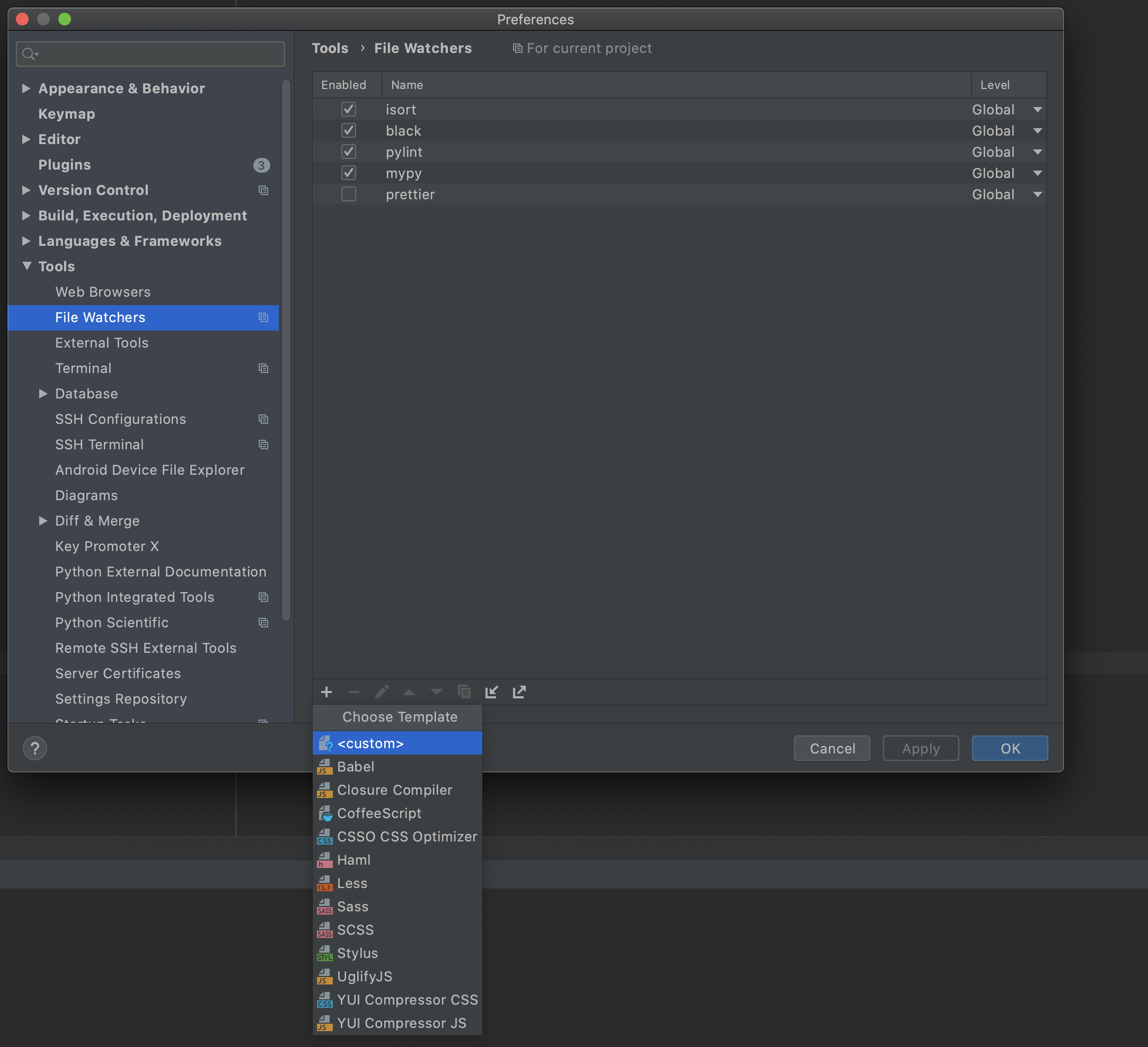

Preferences > Tools > File Watchers

+><custom>からファイル保存時に実行したいコマンドを追加できる

開いたWindowに実行したいコマンドを入力してOKを押せば保存される

項目名 説明 Name 任意の名前 FileType どの拡張子ファイルを保存した時にコマンドを実行するか Scope 基本的にCurrentFIleでOK Program 実行したいコマンドの最初のワード Arguments 実行したいコマンドの二つ目以降のワード Working directory コマンドを実行する際のカレントディレトリ Advanced Options 自動保存時にもコマンドを実行するかなど チェックを外しておくのが無難 以下はPythonファイル保存時にpoetryでpylintを実行する場合の例

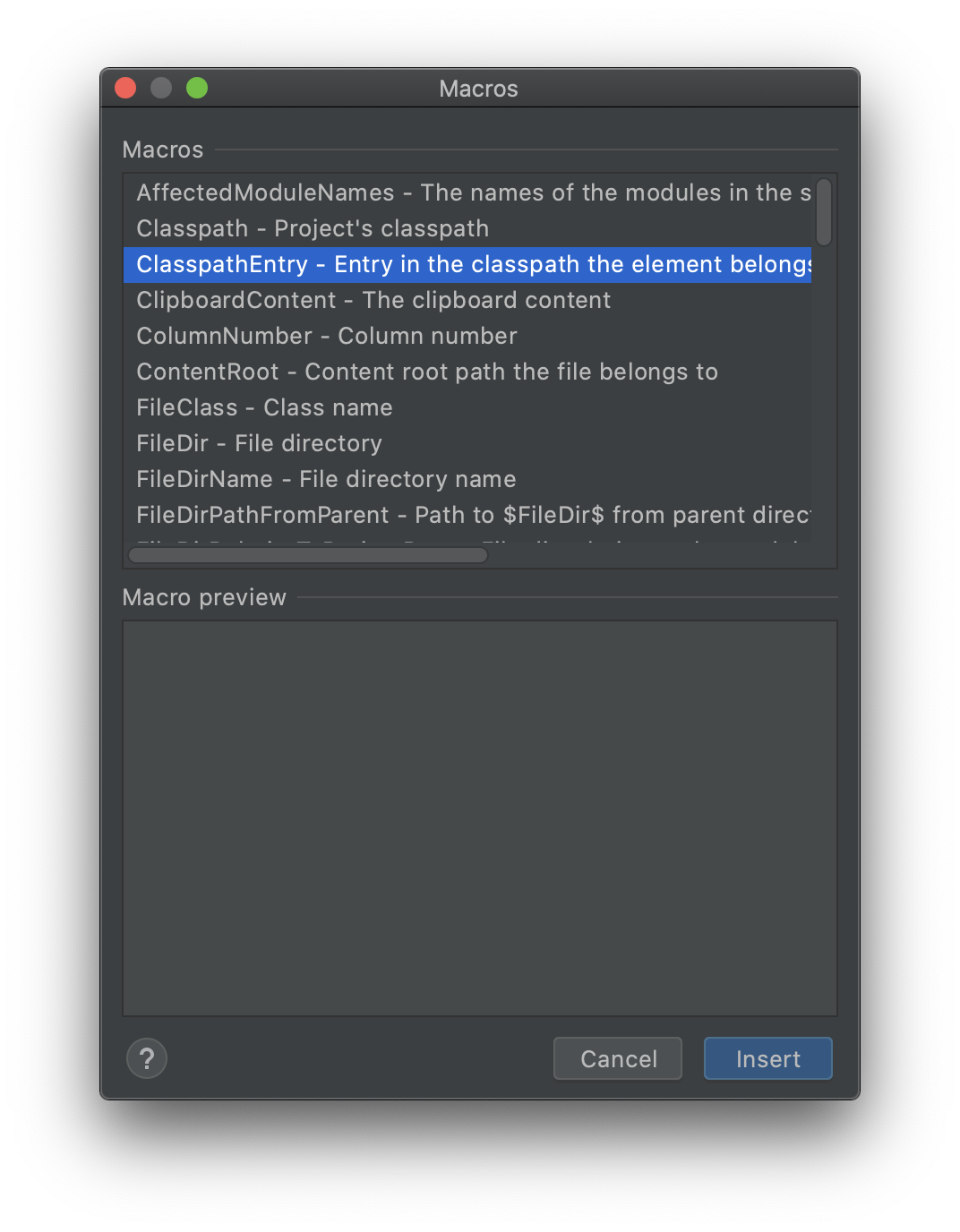

$FilePath$は保存したファイルのパスのマクロ

$FileDir$は保存したファイルののディレクトリパスのマクロ

入力欄の+からマクロ一覧が見れる

プロジェクト間での設定の共有

複数のリポジトリで使いたい時はLevelをGlobalに設定すると、

他のプロジェクトでもFile Watchers設定画面で表示される

デフォルトでEnabledのチェックは外れてるので使用したい場合はチェックを入れる必要あり

- 投稿日:2020-09-16T23:09:06+09:00

OpenCVでエッジを抜き出す(ラプラシアン、ソーベル、キャニー)

機械学習に使う画像の前処理

コンピュータに「その画像に何が写っているか」を理解させるためには検出対象の輪郭を描き、そこから特徴を見つけ出すというプロセスが多く取られます。

その輪郭を描く部分をPython+OpenCVで3つの方法で行った結果をこの記事では掲載します。

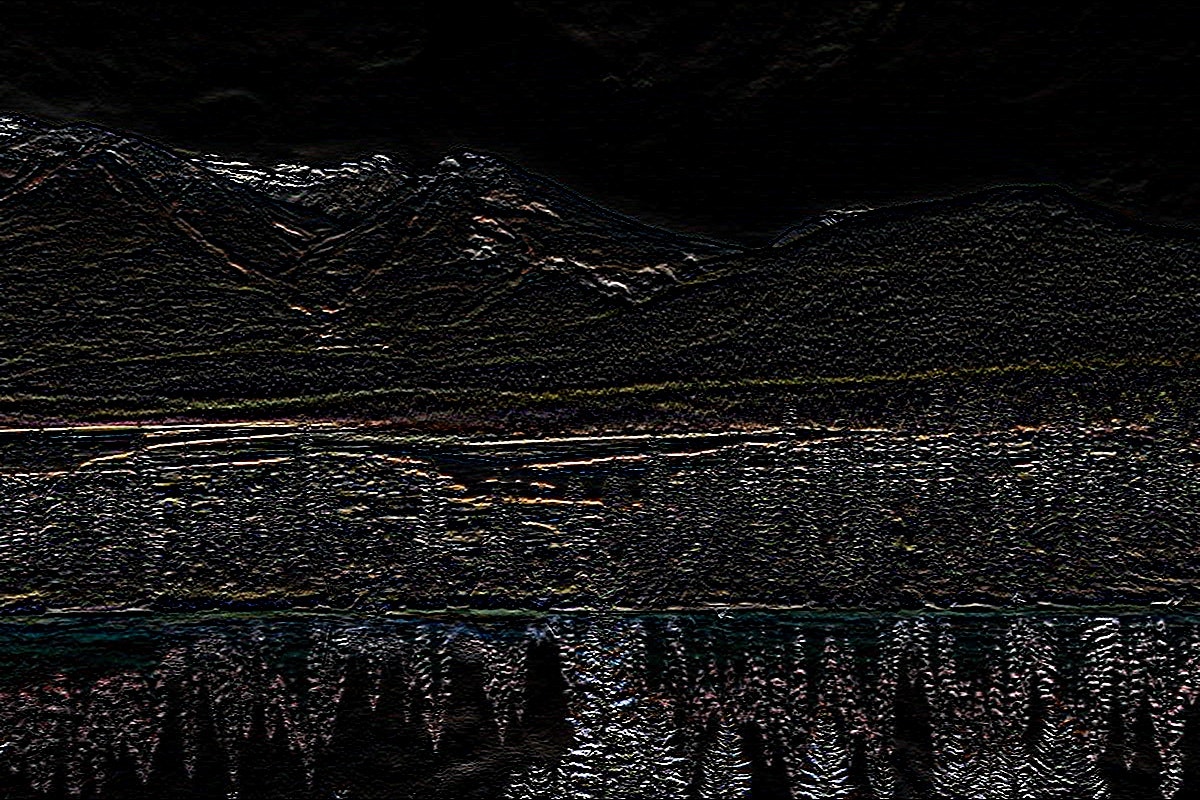

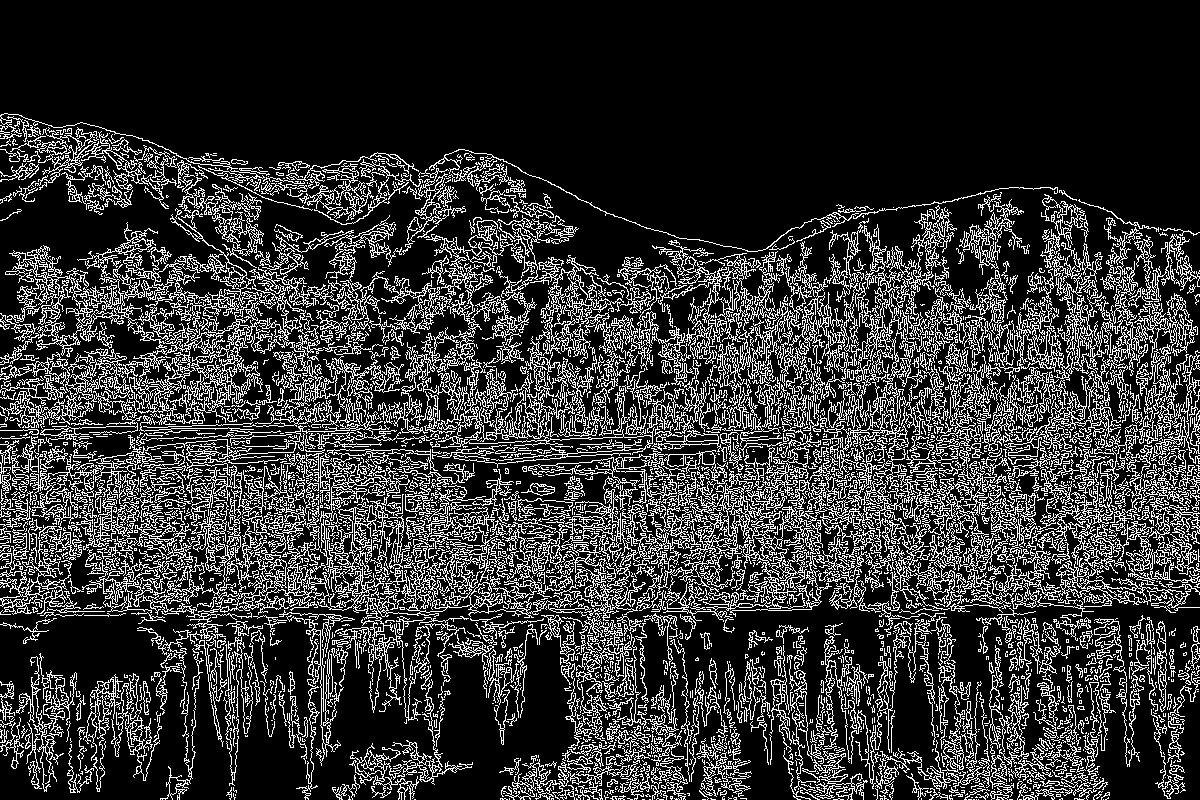

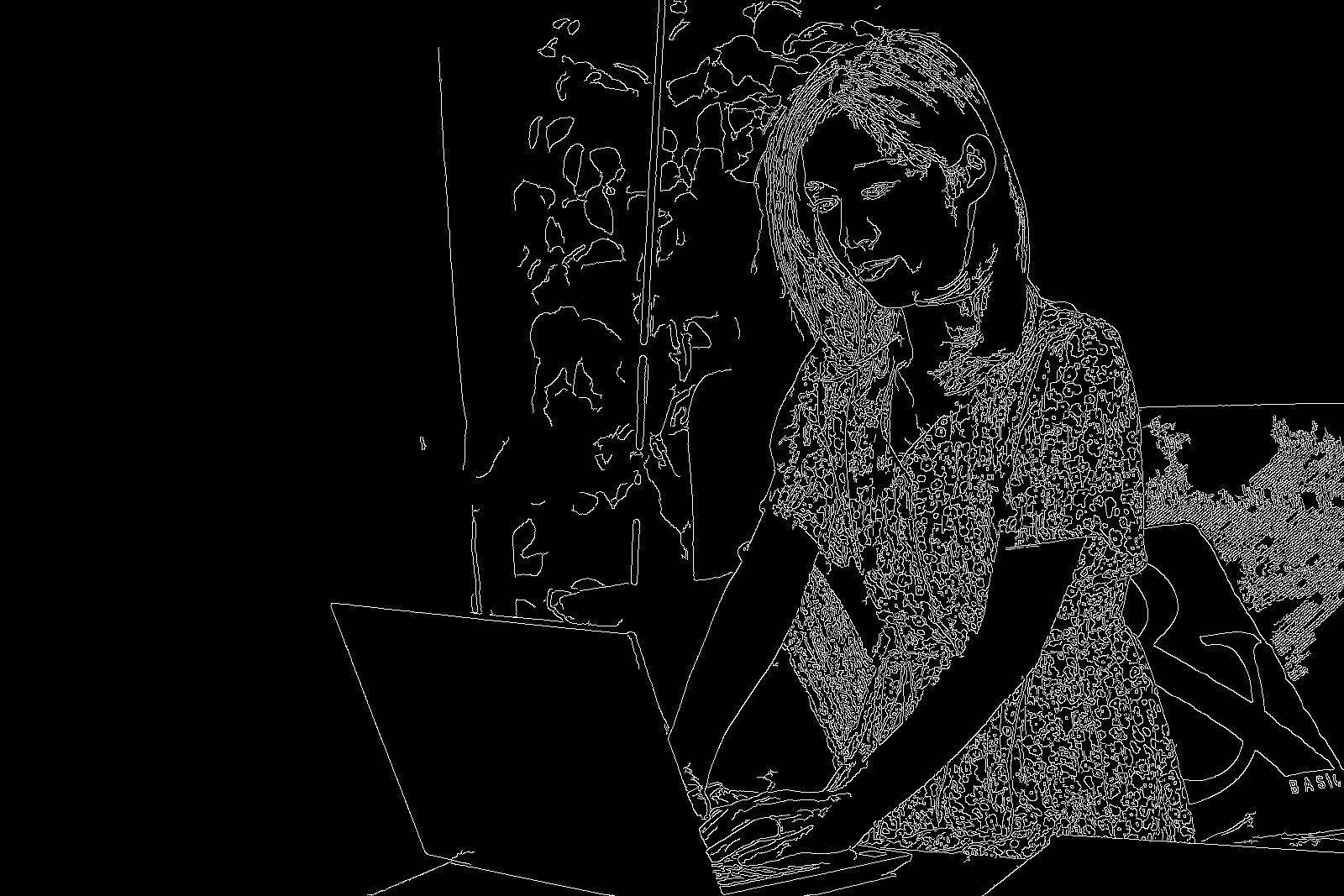

元画像

加工元となる画像は2つ用意しました。

コード

この程度です。

edge.pyimport cv2 img = cv2.imread('xxxxxxx.jpg') # エッジ検出 edge_laplacian = cv2.Laplacian(img, -1)#ラプラシアン edge_sobel = cv2.Sobel(img, -1, 0, 1)#ソーベル edge_canny = cv2.Canny(img, 10.0, 200.0)#キャニー # ファイル書き出し cv2.imwrite('laplacian.jpg', edge_laplacian) cv2.imwrite('sobel.jpg', edge_sobel) cv2.imwrite('canny.jpg', edge_canny)出力結果

自然

人間

- 投稿日:2020-09-16T21:39:21+09:00

pythonによるword2vec等によるテキストマイニング(【高等学校情報科 情報Ⅱ】教員研修用教材)

はじめに

過去の記事で青空文庫の作品を題材に簡単なテキストマイニングを行いました。

https://qiita.com/ereyester/items/7c220a49c15073809c33

今回は、Word2vecを使って、単語の類似度を探りたいと思います。

Word2vecについては、ほかにたくさん記事がありますので具体的な説明は省略します。

Word2Vecを理解する

【Python】Word2Vecの使い方

今回は、gensimのgensim.models 内のword2vec.Word2Vec()の関数を中心にまとめていきたいと思います。

絵で理解するWord2vecの仕組み教材

高等学校情報科「情報Ⅱ」教員研修用教材(本編):文部科学省

第3章 情報とデータサイエンス 後半 (PDF:7.6MB)環境

- ipython

- Colaboratory - Google Colab

教材内で取り上げる箇所

学習18 テキストマイニングと画像認識:「2.MeCabを利用したテキストマイニング」

pythonでの実装例と結果

準備

pythonにて、Word2vecで機械学習を行うために、gensimというパッケージを読み込みます。

!pip install gensim次に後で行う感情分析のための感情辞書をダウンロードしておきます。

感情分析の際にWord2vecで感情を示す用語の主な用語との距離を求めることにより感情分析が可能ですが、ここでは日本語辞書として,東京工業大学のPN Tableを使用して感情分析を行います。import urllib.request import pandas as pd #PN tableのリンク url = 'http://www.lr.pi.titech.ac.jp/~takamura/pubs/pn_ja.dic' #ファイル保存名 file_path = 'pn_ja.dic' with urllib.request.urlopen(url) as dl_file: with open(file_path, 'wb') as out_file: out_file.write(dl_file.read()) # 辞書を読み込みます dic = pd.read_csv('/content/pn_ja.dic', sep = ':', encoding= 'shift_jis', names = ('word','reading','Info1', 'PN')) print(dic)実行結果は以下になります。

word reading Info1 PN 0 優れる すぐれる 動詞 1.000000 1 良い よい 形容詞 0.999995 2 喜ぶ よろこぶ 動詞 0.999979 3 褒める ほめる 動詞 0.999979 4 めでたい めでたい 形容詞 0.999645 ... ... ... ... ... 55120 ない ない 助動詞 -0.999997 55121 酷い ひどい 形容詞 -0.999997 55122 病気 びょうき 名詞 -0.999998 55123 死ぬ しぬ 動詞 -0.999999 55124 悪い わるい 形容詞 -1.000000 [55125 rows x 4 columns]次に、Mecabをインストールしておきます。

!apt install aptitude !aptitude install mecab libmecab-dev mecab-ipadic-utf8 git make curl xz-utils file -y !pip install mecab-python3 !pip install unidic-liteWord2vecによるモデル構築とテキストの分析

word2vecで学習をさせるために、分析対象の文章を分かち書きのテキストに変換して保存します。

以下のステップで処理を行います。

①夏目漱石の「坊ちゃん」に対してテキスト分析を行うため「坊ちゃん」のテキストデータをダウンロードし読み込みを行います。

②ルビ、注釈などの除去を行います。

③「坊ちゃん」の本文から、名詞、形容詞、動詞を取り出し、数や非自立語等を取り除き、「分かち書き」に変換して、tf.txtというファイルに変換する。from collections import Counter import MeCab #MeCabを読み出す import zipfile import os.path,glob import re #「坊ちゃん」のURLを指定 url = 'https://www.aozora.gr.jp/cards/000148/files/752_ruby_2438.zip' #zipファイル保存名 file_path = 'temp.zip' # 坊ちゃんのファイルを開き、読み込んだファイルは削除する with urllib.request.urlopen(url) as dl_file: with open(file_path, 'wb') as out_file: out_file.write(dl_file.read()) with zipfile.ZipFile(file_path) as zf: listfiles = zf.namelist() zf.extractall() os.remove(file_path) # shift_jisで読み込み with open(listfiles[0], 'rb') as f: text = f.read().decode('shift_jis') # ルビ、注釈などの除去 text = re.split(r'\-{5,}', text)[2] text = re.split(r'底本:', text)[0] text = re.sub(r'《.+?》', '', text) text = re.sub(r'[#.+?]', '', text) text = text.strip() #MeCabを使えるように準備 tagger = MeCab.Tagger() # 初期化しないとエラーになる tagger.parse("") # NMeCabで形態素解析 node = tagger.parseToNode(text) word_list_raw = [] result_dict_raw = {} # 名詞、形容詞、動詞は取り出す wordclass_list = ['名詞','形容詞','動詞'] # 数、非自立、代名詞、接尾は除外 not_fine_word_class_list = ["数", "非自立", "代名詞","接尾"] while node: #詳細情報を取得 word_feature = node.feature.split(",") #単語を取得(原則、基本形) word = node.surface #品詞を取得 word_class = word_feature[0] fine_word_class = word_feature[1] #品詞から取り出すものと除外するものを指定する if ((word not in ['', ' ','\r', '\u3000']) \ and (word_class in wordclass_list) \ and (fine_word_class not in not_fine_word_class_list)): #wordリスト word_list_raw.append(word) result_dict_raw[word] = [word_class, fine_word_class] #次の単語に進める node = node.next print(word_list_raw) wakachi_text = ' '.join(word_list_raw); #wakachiファイル保存名 file2_path = 'tf.txt' with open(file2_path, 'w') as out_file: out_file.write(wakachi_text) print(wakachi_text)実行結果は以下になります。

['一', '親譲り', '無鉄砲', '小供', '時', '損', 'し', 'いる', '学校',… 一 親譲り 無鉄砲 小供 時 損 し いる 学校 居る 時分 学校 二 階 飛び降り…次に、今回の記事のメインであるword2vecによるモデルの構築です。

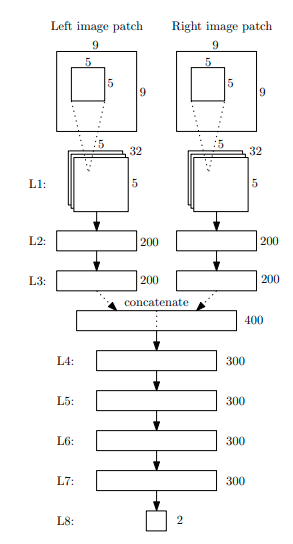

from gensim.models import word2vec import logging logging.basicConfig(format='%(asctime)s : %(levelname)s : %(message)s', level=logging.INFO) sentence_data = word2vec.LineSentence('tf.txt') model_bochan = word2vec.Word2Vec(sentence_data, sg=1, # Skip-gram size=100, # 次元数 min_count=5, # min_count回未満の単語を破棄 window=12, # 文脈の最大単語数 hs=0, # 階層ソフトマックス(ネガティブサンプリングするなら0) negative=5, # ネガティブサンプリング iter=10 # Epoch数 ) model_bochan.save('test.model')gensimモジュールのword2vecをインポートし、Word2Vecでモデルの構築を行います。

word2vecでは、二つの学習モデルが使用できます。

- CBOW(continuous bag-of-words)

- skip-gramこの二つの説明は割愛しますが、教材ではskip-gramを使用しているので、そちらにあわせてskip-gramを使用しています。(一般的には、CBOWとskip-gramでは、skip-gramのほうがよい性能を示すとのこと)

単語ベクトルの次元数は、デフォルトと同じですが100にしています。

単語を破棄条件は、出現回数が5回未満の単語は無視して処理するようにしています。

コンテクストとして認識する前後の最大単語数は12としています。学習を高速化するアルゴリズムとして二つあります。

-Hierarchical Softmax

-Negative Sampling

この二つの説明も割愛します。ここでは、Negative Samplingを使用しています。この説明は、

http://tkengo.github.io/blog/2016/05/09/understand-how-to-learn-word2vec/

が詳しいです。コーパスの反復回数は10を指定しています。これは、一つの訓練データをニューラルネットワークで何回学習させるかを示すエポック数のことです。

これにより、モデルを構築することができました。

次に教材同様、単語の類似度をみてみます。

赤という単語で調べてみましょう。model = word2vec.Word2Vec.load('/content/test.model') results = model.most_similar(positive=['赤'], topn=100) for result in results: print(result[0], '\t', result[1])実行結果は以下になりました。

: 2020-09-16 12:30:12,986 : INFO : precomputing L2-norms of word weight vectors シャツ 0.9854607582092285 迷惑 0.9401918053627014 名 0.9231084585189819 ゴルキ 0.9050831198692322 知っ 0.8979452252388 優しい 0.897865891456604 賛成 0.8932155966758728 露西亜 0.8931306004524231 マドンナ 0.890703558921814 :上記のように、登場人物の赤シャツなどが上位に来ることがわかりました。

次に、モデルの要素の引き算の例として、「マドンナ」から「シャツ」を引いてみます。model = word2vec.Word2Vec.load('/content/test.model') results = model.most_similar(positive=['マドンナ'], negative=['シャツ'], topn=100) for result in results: print(result[0], '\t', result[1])実行結果は以下になりました。

: INFO : precomputing L2-norms of word weight vectors 声 0.2074282020330429 芸者 0.1831434667110443 団子 0.13945674896240234 娯楽 0.13744047284126282 天麩羅 0.11241232603788376 バッタ 0.10779635608196259 先生 0.08393052220344543 精神 0.08120302855968475 親切 0.0712042897939682 :マドンナからシャツという要素を引くと、声や先生、芸者、親切などの要素を抽出できました。

word2vecによる要素の足し引きについて、以下が詳しいです。

https://www.pc-koubou.jp/magazine/9905PN tableによる簡単な感情分析

感情分析は、Word2Vecでも感情の主要用語との距離を求めることにより、感情分析が可能であるが、ここでは教材通り前述で読み込んだ感情辞書(PN Table)で分析を行ってみたいと思います。

まず、辞書をdataframe型からdict型に変換し扱いやすい形にしておきます。

dic2 = dic[['word', 'PN']].rename(columns={'word': 'TERM'}) # PN Tableをデータフレームからdict型に変換しておく word_list = list(dic2['TERM']) pn_list = list(dic2['PN']) # 中身の型はnumpy.float64 pn_dict = dict(zip(word_list, pn_list)) print(pn_dict)実行結果は以下になりました。

{'優れる': 1.0, '良い': 0.9999950000000001, '喜ぶ': 0.9999790000000001, '褒める': 0.9999790000000001, 'めでたい': 0.9996450000000001,…ポジティブな用語は1に近い値が設定され、ネガティブな用語については-1に近い値が設定されています。

次に、「坊ちゃん」から名詞と形容詞を取り出し、数や接尾語を取り除きます。単語の頻度表と感情辞書を組み合わせて、ポジティブな言葉とネガティブな言葉を表示してみます。

#MeCabを使えるように準備 tagger = MeCab.Tagger() # 初期化しないとエラーになる tagger.parse("") # NMeCabで形態素解析 node = tagger.parseToNode(text) word_list_raw = [] extra_result_list = [] # 名詞、形容詞、動詞は取り出す wordclass_list = ['名詞','形容詞'] # 数、非自立、代名詞、接尾は除外 not_fine_word_class_list = ["数","接尾", "非自立"] while node: #詳細情報を取得 word_feature = node.feature.split(",") #単語を取得(原則、基本形) word = node.surface #品詞を取得 word_class = word_feature[0] fine_word_class = word_feature[1] #品詞から取り出すものと除外するものを指定する if ((word not in ['', ' ','\r', '\u3000']) \ and (word_class in wordclass_list) \ and (fine_word_class not in not_fine_word_class_list)): #wordリスト word_list_raw.append(word) #次の単語に進める node = node.next freq_counterlist_raw = Counter(word_list_raw) dict_freq_raw = dict(freq_counterlist_raw) extra_result_list = [] for k, v in dict_freq_raw.items(): if k in pn_dict: extra_result_list.append([k, v, pn_dict[k]]) extra_result_pn_sorted_list = sorted(extra_result_list, key=lambda x:x[2], reverse=True) print("ポジティブな単語") display(extra_result_pn_sorted_list[:10]) print("ネガティブな単語") display(extra_result_pn_sorted_list[-10:-1])実行結果は以下になりました。

ポジティブな単語 [['めでたい', 1, 0.9996450000000001], ['善い', 2, 0.9993139999999999], ['嬉しい', 1, 0.998871], ['仕合せ', 1, 0.998208], ['手柄', 2, 0.997308], ['正義', 1, 0.9972780000000001], ['感心', 10, 0.997201], ['恐悦', 1, 0.9967889999999999], ['奨励', 1, 0.9959040000000001], ['剴切', 1, 0.995553]] ネガティブな単語 [['乱暴', 13, -0.9993340000000001], ['狭い', 7, -0.999342], ['寒い', 1, -0.999383], ['罰', 5, -0.9994299999999999], ['敵', 3, -0.9995790000000001], ['苦しい', 1, -0.9997879999999999], ['下手', 6, -0.9998309999999999], ['ない', 338, -0.9999969999999999], ['病気', 6, -0.9999979999999999]]listの要素の2つ目が出現頻度(回数)、3つ目がポジティブかネガティブかわかる値となっております。

最後に、「坊ちゃん」全体としては、ポジティブ・ネガティブどちらの単語がよく使われているかをみてみる。(ただし、教材通り単語の出現頻度は使用していない)pos_n = sum(x[2] > 0 for x in extra_result_pn_sorted_list) print(pos_n) neg_n = sum(x[2] < 0 for x in extra_result_pn_sorted_list) print(neg_n)実行結果は以下になりました。

182 1914「坊ちゃん」ではネガティブな単語がよくつかわれていることがわかりました。

コメント

word2vecに関する処理に関してはpythonとRで似たような結果が出なかったので、今後余裕があったら原因を探っていこうと思います。

ソースコード

https://gist.github.com/ereyester/101ae0da17e747b701b67fe9fe137b84

- 投稿日:2020-09-16T21:20:55+09:00

Django + Docker

はじめに

この記事ではDjango + Dockerのアプリ開発でおきたエラーとその対処法を書いていきます。

ERROR: No container found for web_1

いろいろ試してみてたのですが、一向に対処法がわからなかったのですが、次のようにターミナルに打ち込めば解決しました。

terminal$ docker-compose up -d参考記事

ERROR: No container found for web_1 #11045TypeError: Field 'id' expected a number but got datetime.datetime(2020, 9, 16, 2, 52, 51, 44897, tzinfo=).

models.pyのForignkeyがあるところに次のように追記しました。

models.pyuser = models.OneToOneField( User, verbose_name='ユーザー', on_delete=models.CASCADE, default=1 #追記 )これで解決しました。

django.db.utils.OperationalError: could not translate host name "db" to address: Name or service not known

sqlite3を使っていたのですが、このエラーが頻繁に出るので、Postgresqlを導入しました。

手順としてはこちらを参照してください。

ERROR: yaml.scanner.ScannerError: while scanning for the next token

このエラーでは「docker-compose.yml」のインデントを確認してみてください。

コメントアウトしているものでも、インデントがずれていると怒られるので注意してください。yaml.parser.ParserError: while parsing a block mapping

このエラーでも「docker-compose.yml」のインデントを確認してみてください。

- 投稿日:2020-09-16T19:59:34+09:00

swagger-codegenを使ってpython-flaskのモックサーバーを秒で立てたい。

はじめに

業務の中でWebサーバーなんぞ詳しくないのに、

PoC用にWebサーバーを立てろ(しかも秒で)と言われた経験がある方にswagger-codegenをご紹介します。

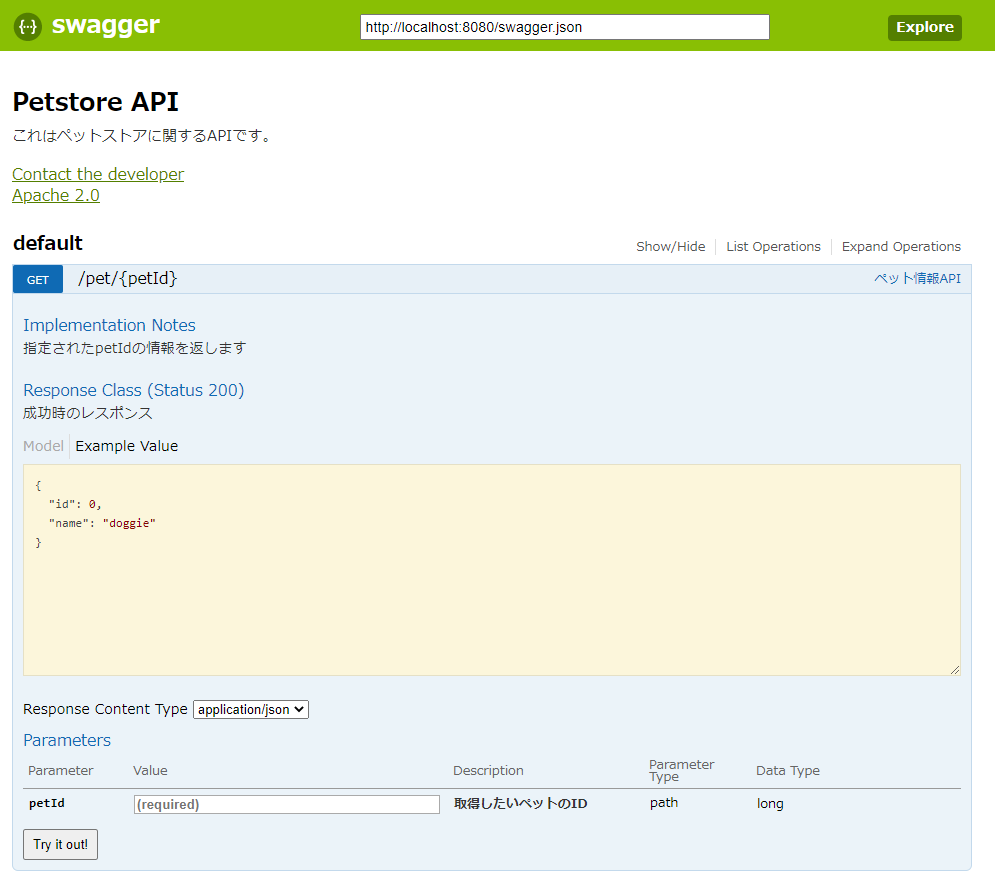

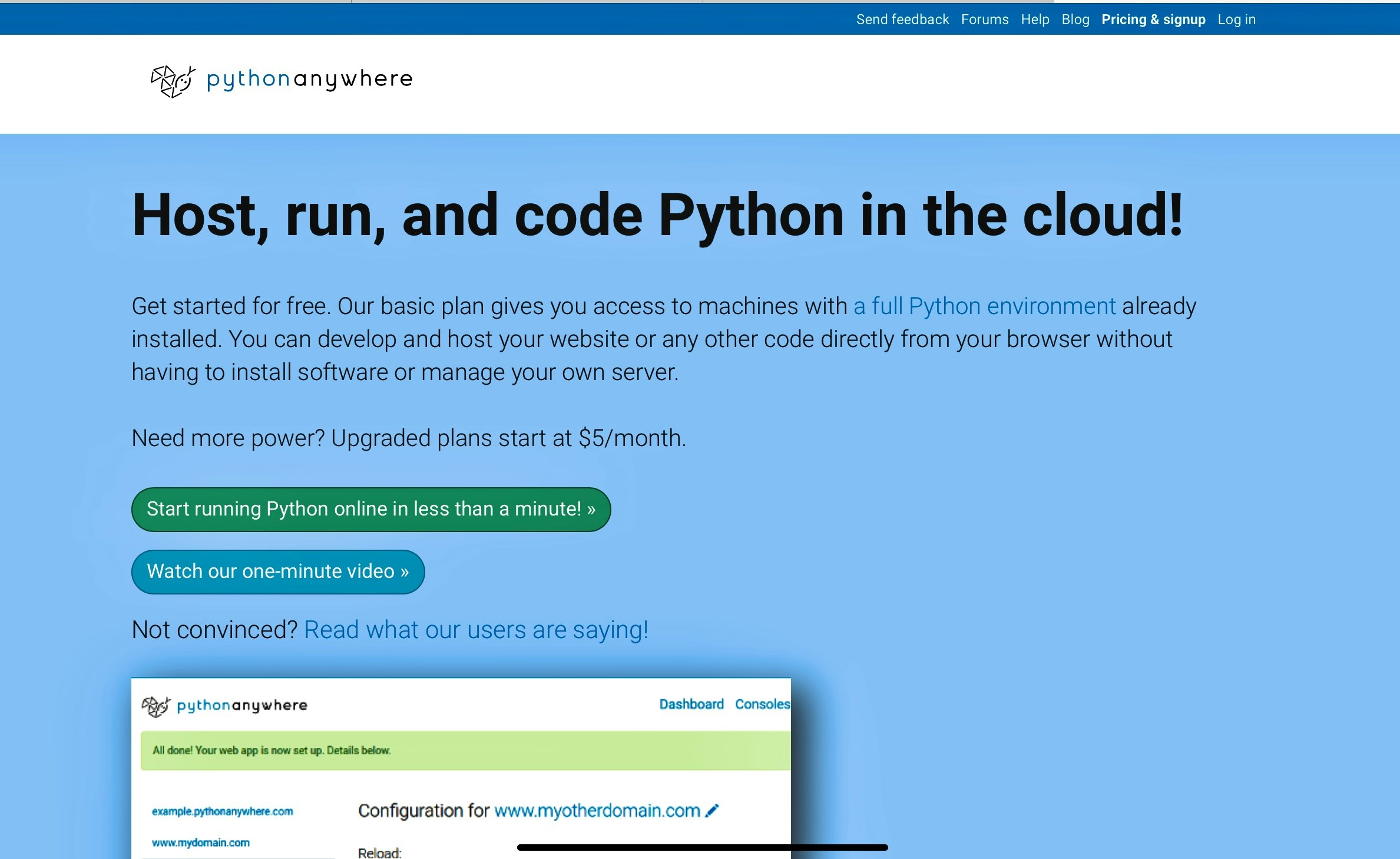

(秒では立てられないかもしれませんが、API仕様さえyamlで書ければ簡単にサーバーまで立てられます。)swagger-codegenについて

swagger-codegenはYAML(or JSON)でAPI仕様を定義すると、

そのAPI定義通りにモックサーバーを作り、

さらに、以下のようにそのAPIを叩けるブラウザUI画面を作成できます。使用環境

- OS ... Windows 10 Home(64bit)

- Python ... conda環境

- その他、JREが必要

JREのインストール

JREがない場合は以下よりダウンロード&インストールをする。

- https://www.java.com/ja/download/manual.jspswagger-codegen-cli.jarの取得

mavenのレポジトリから取得する。

- https://repo1.maven.org/maven2/io/swagger/今回は以下の2.4.15を使用した。

- https://repo1.maven.org/maven2/io/swagger/swagger-codegen-cli/2.4.15API仕様をswagger.yamlに定義

API仕様を定義してあげると、その定義に沿ってモックサーバーができます。

以下のようなファイルをどこか適当に作成します。swagger.yamlswagger: "2.0" info: description: "これはペットストアに関するAPIです。" version: "1.0.0" title: "Petstore API" termsOfService: "http://swagger.io/terms/" contact: email: "apiteam@swagger.io" license: name: "Apache 2.0" url: "http://www.apache.org/licenses/LICENSE-2.0.html" paths: /pet/{petId}: get: summary: "ペット情報API" description: "指定されたpetIdの情報を返します" parameters: - name: "petId" in: "path" description: "取得したいペットのID" required: true type: "integer" format: "int64" responses: 200: description: "成功時のレスポンス" schema: type: "object" properties: id: type: "integer" format: "int64" name: type: "string" example: "doggie"swagger.yml内の記述の意味は以下をご参考にしてください。

- https://qiita.com/rllllho/items/53a0023b32f4c0f8eabbモックサーバーを作成

今回は慣れ親しんだpythonを使いたいので、pytoh-flaskでモックサーバーを作成します。

> java -jar {ダウンロードしたjarファイル} generate -i swagger.yaml -l python-flask -o test-server

-lオプションを変えればGoでもNode.jsでもRuby on Railsでもなんでも作れます。

他に-lオプションに何があるかは以下を参考にしてください。

- https://github.com/swagger-api/swagger-codegen/wiki/Server-stub-generator-HOWTO作成されたフォルダ構成

python-flaskの場合、こんな感じでモックサーバーができます。

Dockerfileもできていますので、Dockerコンテナにすることも可能です。> tree server server ├── Dockerfile ├── README.md ├── git_push.sh ├── requirements.txt ├── setup.py ├── swagger_server │ ├── __init__.py │ ├── __main__.py │ ├── controllers │ │ ├── __init__.py │ │ └── default_controller.py │ ├── encoder.py │ ├── models │ │ ├── __init__.py │ │ ├── base_model_.py │ │ └── inline_response200.py │ ├── swagger │ │ └── swagger.yaml │ ├── test │ │ ├── __init__.py │ │ └── test_default_controller.py │ └── util.py ├── test-requirements.txt └── tox.iniこの中で、実際の処理を記載するのは、

default_controller.pyのpet_pet_id_getの部分になります。default_controller.pyimport connexion import six from swagger_server.models.inline_response200 import InlineResponse200 # noqa: E501 from swagger_server import util def pet_pet_id_get(petId): # noqa: E501 """ペット情報API 指定されたpetIdの情報を返します # noqa: E501 :param petId: 取得したいペットのID :type petId: int :rtype: InlineResponse200 """ return 'do some magic!'Windows上のconda環境で動かしてみる。

必要なパッケージをインストールします。

swagger-codegenによって作られた環境にはpipのrequirements.txtしか書いていませんが、

conda環境では以下をインストールすれば動かすことができます。> conda install connexion > conda install swagger-ui-bundle起動します。

> cd test-server > python -m swagger_server以下にブラウザからアクセスして画面が見えたら起動できています。

- http://localhost:8080/ui/以上、お疲れさまでした!

- 投稿日:2020-09-16T19:52:11+09:00

Python参照ページ

Pythonを扱う上で参考にしたWebページの一覧

Pythonリスト内包表記

https://note.nkmk.me/python-list-comprehension/

基本型

[式 for 任意の変数名 in イテラブルオブジェクト]!!ファイルを読み込んだものから改行コードを取りたいときはf.read().splitlines()でいい!!

https://qiita.com/suzuki-hoge/items/8eac60f7b68044eea6c1pythonでのファイルの読み込み、書き込み

https://note.nkmk.me/python-file-io-open-with/python 辞書のfor文

https://note.nkmk.me/python-dict-keys-values-items/python strip系

https://note.nkmk.me/python-str-remove-strip/python 配列の初期化

https://www.javadrive.jp/python/list/index12.htmlpython 文字列の扱い

https://qiita.com/tomotaka_ito/items/594ee1396cf982ba9887python if not

https://www.sejuku.net/blog/65070pythonで冪乗を扱う

https://www.sejuku.net/blog/71405

- 投稿日:2020-09-16T18:41:54+09:00

Python × GISの基礎(その2)

その1はこちら

ヘルシンキ大学の教材のWeek3-Week4の解答と補足をまとめていきます。Week3

3-1 ショッピングセンターのジオコーディング

ヘルシンキにある大型ショッピングモールの周囲1.5kmに住んでいる住民の数、すなわち商圏人口を求めることが目標です。自分でネットで検索してモールの住所を調べる必要があります。

住所から座標に変換するジオコーディングが登場します。日本では東京大学が提供しているCSVアドレスマッチングサービスが有名ですね。

またバッファリング・空間結合といったQGISでお馴染みの操作も登場します。import geopandas as gpd import pandas as pd import matplotlib.pyplot as plt import requests import geojson from shapely.geometry import Polygon, LineString, Point from pyproj import CRS import os #データ読み込み data = pd.read_table('shopping_centers.txt', sep=';', header=None) data.index.name = 'id' data.columns=['name', 'addr'] #ジオコーディング geo = geocode(data['addr'], provider='nominatim', user_agent='autogis_xx', timeout=4) #データの結合 geo = geo.to_crs(CRS.from_epsg(3879)) geodata = geo.join(data) #バッファリング geodata['buffer']=None geodata['buffer'] = geodata['geometry'].buffer(distance=1500) geodata['geometry'] = geodata['buffer'] #人口のグリッドデータの取得 url = 'https://kartta.hsy.fi/geoserver/wfs' params = dict(service='WFS',version='2.0.0',request='GetFeature', typeName='asuminen_ja_maankaytto:Vaestotietoruudukko_2018',outputFormat='json') r = requests.get(url, params=params) pop = gpd.GeoDataFrame.from_features(geojson.loads(r.content)) #座標系変換 pop = pop[['geometry', 'asukkaita']] pop.crs = CRS.from_epsg(3879).to_wkt() geodata = geodata.to_crs(pop.crs) #空間結合 join = gpd.sjoin(geodata, pop, how="inner", op="intersects") #商圏人口の計算 grouped = join.groupby('name') for key, group in grouped: print('store: ', key,"\n", 'population:', sum(group['asukkaita']))3-2 最寄りのショッピングセンター

自分の家と職場から最寄りのショッピングセンターを求めます。フィンランドに住んでいる方は別ですが、適当なヘルシンキのスポットを基点の住所として置きましょう。

(以下ライブラリのインポートは省略しています。)#データの読み込み home = pd.read_table('activity_locations.txt', sep=';', header=None) home.index.name='id' home.columns = ['name', 'addr'] shop = pd.read_table('shopping_centers.txt', sep=';', header=None) shop.index.name = 'id' shop.columns=['name', 'addr'] #ジオコーディング geo_home = geocode(home['addr'], provider='nominatim', user_agent='autogis_xx', timeout=4) geo_shop = geocode(shop['addr'], provider='nominatim', user_agent='autogis_xx', timeout=4) #最寄り店を求める destinations = MultiPoint(list(geo_shop['geometry'])) for home in geo_home['geometry']: nearest_geoms = nearest_points(home, destinations) print(nearest_geoms[1])Week4

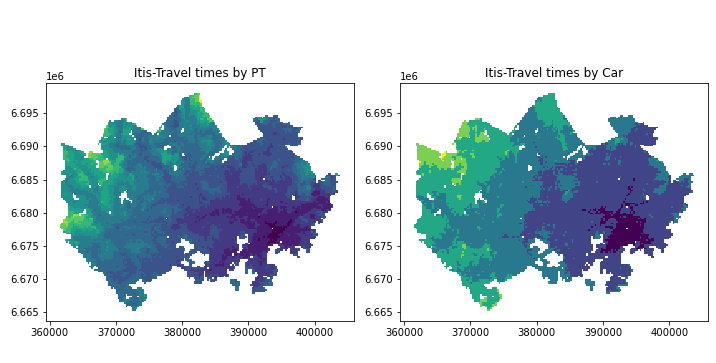

4-1 アクセシビリティデータの可視化

移動時間データと地下鉄網のデータを組み合わせて、アクセシビリティを可視化します。

#データの読み込み grid = gpd.read_file('data/MetropAccess_YKR_grid_EurefFIN.shp') data = pd.read_table('data/TravelTimes_to_5944003_Itis.txt', sep=';') data = data[["pt_r_t", "car_r_t", "from_id", "to_id"]] #データ結合 data_geo = grid.merge(data, left_on='YKR_ID', right_on='from_id') #無効データ(-1)の除外 import numpy as np data_geo = data_geo.replace(-1, np.nan) data_geo = data_geo.dropna() #データの階層化 import mapclassify bins = [15, 30, 45, 60, 75, 90, 105, 120, 135, 150, 165, 180] classifier = mapclassify.UserDefined.make(bins = bins) data_geo['pt_r_t_cl'] = data_geo[['pt_r_t']].apply(classifier) data_geo['car_r_t_cl'] = data_geo[['car_r_t']].apply(classifier) #可視化 fig = plt.figure(figsize=(10,10)) ax1 = fig.add_subplot(1, 2, 1) #公共交通 data_geo.plot(ax=ax1, column='pt_r_t_cl') ax1.set_title("Itis-Travel times by PT") ax2 = fig.add_subplot(1, 2, 2) #自家用車 data_geo.plot(ax=ax2, column='car_r_t_cl') ax2.set_title("Itis-Travel times by Car") plt.tight_layout() plt.show() fig.savefig('itis_accessibility.png')4-2ショッピングモールの勢力圏

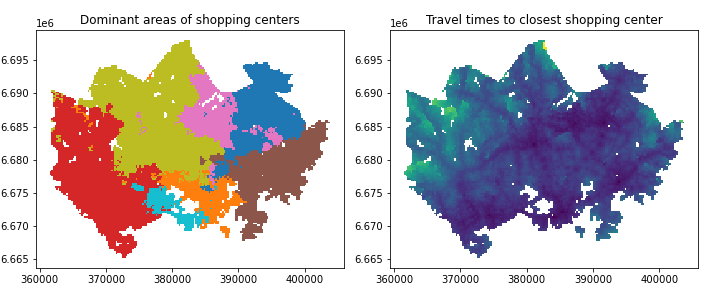

4-1で得たアクセシビリティのデータをもとに、各グリッドの最寄りのショッピングモールを求めることで勢力圏の可視化を目指します。

#データの読み込み filepaths = glob.glob('data/TravelTimes*.txt') for path in filepaths: data = pd.read_table(path, sep=';') data = data[['from_id', 'pt_r_t']] data = data.rename(columns={'from_id':'YKR_ID'}) #カラム名を'pt_r_t_{store}'に変更 newname = path.replace('data/TravelTimes_to_', '') newname = newname.replace('.txt', '') newname = re.sub('\d{7}_', '', newname) data = data.rename(columns={'pt_r_t':'pt_r_t_'+newname}) grid = grid.merge(data) #データの結合 grid = gpd.read_file('data/MetropAccess_YKR_grid_EurefFIN.shp') #無効データ(-1)の除外 import numpy as np grid = grid.replace(-1, np.nan) grid = grid.dropna() #各グリッドのモールへの最短距離・モール名 grid['min_t'] = None grid['dominant_service'] = None columns = ['pt_r_t_Ruoholahti', 'pt_r_t_Myyrmanni','pt_r_t_Itis', 'pt_r_t_Jumbo', 'pt_r_t_IsoOmena', 'pt_r_t_Dixi','pt_r_t_Forum'] mini = lambda row:row[columns].min() idx = lambda row:row[columns].astype(float).idxmin() grid['min_t'] = grid.apply(mini, axis=1) grid['dominant_service'] = grid.apply(idx, axis=1)4-3 ショッピングモールの勢圏人口

グリッドデータに対してディゾルブを使い集約化しインターセクションで勢圏人口を求める、というベタなものです。

4-2と重複する箇所は省略します。#4-2のステップを進め, 勢圏を含むpopデータを作成 #ディゾルブしてインターセクション dissolved = grid.dissolve(by = 'dominant_service') pop = pop[['geometry', 'asukkaita']] #必要なデータに限定 intersection = gpd.overlay(grid, pop, how='intersection') #勢圏でグルーピングして勢圏人口を求める grouped = intersection.groupby('dominant_service') for key, group in grouped: print(key, ':', sum(group['asukkaita']))

- 投稿日:2020-09-16T18:07:04+09:00

tensorflow==2.0.0でDQNを学習したらmemory-leakが発生した

はじめに

最近研究で使うDQNをそこそこ苦労しながら実装し、それの学習を回したところ異常な程Memoryを食っており、原因究明に1週間もかかってしまいました。

自分のような人が現れないように、簡単に記録を残していきたいと思います。環境

python==3.7

Tensorflow==2.0.0

Ubuntu 18.04実際に発生した現象

私が使っていたのは、研究室に設置されたDeepStationと呼ばれる学習用サーバです。

これは、GTX1080ti * 4と RAMが64GBあるので、少々無理やり動作させても変なことは起きたことがありませんでした。

しかし、環境を更新して普通にEnd-to-Endの識別モデルの学習を行っている時には発生していませんでした。しかし、DQNで学習を行っていた際に問題が発生しました。

今回のDQNの実装に参考にしたのは以下の記事になります。https://qiita.com/sugulu_Ogawa_ISID/items/bc7c70e6658f204f85f9

このソースコードを実行して放置していると、三時間ぐらいで64GBをオーバーしてmemory-overでクラッシュしてしまいました。

最初はソースコードに問題があると思い、一行ずつソースコードを確認していましたが特に問題が見つからず苦労していました。

もともと、Pythonはmemory-leakが起きにくいというのもあり、あまり意識したことがなかったためです。このソースコードを見ればわかりますが、episideが閾値を超えると毎回model.fit()を呼び出して少しずつ学習を行っています。

問題はここにありました。

以下をみてもらえれば、似たような症状が見つかります。https://github.com/tensorflow/tensorflow/issues/33030

これをみてみると、一回model.fitやmodel.predictをしているのは大きな問題ではなく、コレを複数回行うことでmemory-leakが発生したようです。

おそらくですが、model.fitやmodel.predictで呼び出されたmodelがreleaseされずに保持されていたんじゃないかなーと思います。解決方法

基本的には、tensorflowのversionをupdateすればOKです。

私は、tenosorflow==2.3.0をインストールすることで、解決しました。このせいで、一週間も時間を取られるとは思いませんでした。

memory leakって本当に起きるんだーって思いました。

jupyter-labで実行していると、メモリをエラーで開放してくれるわけではなかったためPCにもなかなかログインできずかなり焦りました。

大きくメモリを持っていても過信せずに、pythonのメモリ使用に制限しておくと安心ですね。今は私もそうしています。

以下の記事を参考すると良いでしょう。https://blog.imind.jp/entry/2019/08/10/022501

最後に

DQNで学習していても似たような情報があんまり出ていなかったので、よくわからず苦労しました。

これがみんさんの参考に慣れば幸いです。

- 投稿日:2020-09-16T17:58:44+09:00

for文で使える関数

for文で使える関数

Python では繰り返し処理を行うために for 文が使用されます。

回数を指定して繰り返すなどの処理を行いたい場合には range 関数と組み合わせる。range()関数

0から始まり、1(デフォルト)で増減する一連の数値を返し、指定した数値の前で停止します。

range(開始, 終了, ステップ)

使い方 説明 開始 開始位置を指定する整数。デフォルトは0です。 終了 終了後位置を指定する整数。 ステップ インクリメント、デクリメントを指定する整数。デフォルトは1である。 開始 開始位置を指定する整数。デフォルトは0です。

終了 終了後位置を指定する整数。

ステップ インクリメント、デクリメントを指定する整数。デフォルトは1である。range(開始, 終了, ステップ)

for f in renge(5)

※この場合は、開始=「デフォルトの0」ステップ=「デフォルトの1」が適用される。print (f, end = ‘ ’)

01234

「終了」に指定した値は含まれないので4が返される。仮に5まで取得可能したい場合は、6を指定すればいいです。range(1, 5, 2)

※この場合は1から4まで2づつ増えるrange(10, 5, -2)

※この場合は10から6まで2づつ減るprint(list(range(3)))

この形にすると、リスト型で取得することができるらしいです。ループカウンタ

恥ずかしながら、ループカウンタの意味を知らなかったので調べてきました。

ループを制御する変数で、繰り返し処理の終了条件が処理回数の場合に使用して、処理を1回行うたびに、ループカウンターを1加算し、何回処理が行われたかをカウントして制御する。

上記の意味をループカウンタと言うそうです。Python、でループカウンタを使用したい場合はenumerate()関数を使用する。

enumerate()

l = [‘kokugo’, ‘suugaku’, ‘eigo’]

for i, subject in enumerate(l):

print(i, subject)

0 kokugo

1 suugaku

2 eigo※enumerate()の第2引数を指定しない場合は0からになる

以下のように、第2引数を指定した場合は、指定した数値からループカウンタが返される。

l = [‘kokugo’, ‘suugaku’, ‘eigo’]

for i, subject in enumerate(l, 11):

print(i, subject)

11 kokugo

12 suugaku

13 eigozip()

ループカウンタはzip()関数を使用して定義することも可能ですfor i , w in zip(['kokugo', 'suugaku', 'eigo'], [78, 82, 54]):

print(subject, number)

kokugo 78

suugaku 82

eigo 54以下のように、ループ内容を変数で定義することも可能です

subject = ['kokugo', 'suugaku', 'eigo']

number = [78, 82, 54]for i , w in zip(subject, number):

print(subject, number)

kokugo 78

suugaku 82

eigo 54

- 投稿日:2020-09-16T17:21:09+09:00

pyautoGUIでopencvを入れたらエラーになる

概要

pythonでRPAを行うために、

pyautoguiを使っているとき、

許容誤差や、グレースケール認識などを行いたいときがあります。

その時にopencvを入れる必要が出てきます。ところが、結局使えませんでした。

エラー内容と回避策を載せておきます。エラー内容

pos = pyautogui.locateCenterOnScreen(GetImage(imgname), region=inputregion)

このコードが、これまで動いていたのに、急に動かなくなりました。

pip opencv-pythonして、

pos = pyautogui.locateCenterOnScreen(GetImage(imgname), region=inputregion, grayscale=True)

と書き換えてグレースケールに対応させようとしました。output============================= test session starts ============================= platform win32 -- Python 3.8.5, pytest-6.0.2, py-1.9.0, pluggy-0.13.1 ================================== FAILURES =================================== pos = pyautogui.locateCenterOnScreen(GetImage(imgname), region=inputregion,grayscale=True) C:\tools\miniconda3\envs\rpa2\lib\site-packages\pyautogui\__init__.py:175: in wrapper return wrappedFunction(*args, **kwargs) C:\tools\miniconda3\envs\rpa2\lib\site-packages\pyautogui\__init__.py:207: in locateCenterOnScreen return pyscreeze.locateCenterOnScreen(*args, **kwargs) C:\tools\miniconda3\envs\rpa2\lib\site-packages\pyscreeze\__init__.py:400: in locateCenterOnScreen coords = locateOnScreen(image, **kwargs) C:\tools\miniconda3\envs\rpa2\lib\site-packages\pyscreeze\__init__.py:360: in locateOnScreen retVal = locate(image, screenshotIm, **kwargs) C:\tools\miniconda3\envs\rpa2\lib\site-packages\pyscreeze\__init__.py:340: in locate points = tuple(locateAll(needleImage, haystackImage, **kwargs)) _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ needleImage = array([[31, 31, 31, ..., 31, 31, 31], [31, 31, 31, ..., 31, 31, 31], [31, 31, 31, ..., 31, 31, 31], ...31, 31, 31, ..., 31, 31, 31], [31, 31, 31, ..., 31, 31, 31], [31, 31, 31, ..., 31, 31, 31]], dtype=uint8) haystackImage = array([[60, 60, 60, ..., 60, 60, 60], [60, 60, 60, ..., 60, 60, 60], [60, 60, 60, ..., 60, 60, 60], ...16, 16, 16, ..., 16, 16, 16], [16, 16, 16, ..., 16, 16, 16], [16, 16, 16, ..., 16, 16, 16]], dtype=uint8) grayscale = True, limit = 1, region = (0, 945.0, 240.0, 135.0), step = 1 confidence = 0.999 def _locateAll_opencv(needleImage, haystackImage, grayscale=None, limit=10000, region=None, step=1, confidence=0.999): """ TODO - rewrite this faster but more memory-intensive than pure python step 2 skips every other row and column = ~3x faster but prone to miss; to compensate, the algorithm automatically reduces the confidence threshold by 5% (which helps but will not avoid all misses). limitations: - OpenCV 3.x & python 3.x not tested - RGBA images are treated as RBG (ignores alpha channel) """ if grayscale is None: grayscale = GRAYSCALE_DEFAULT confidence = float(confidence) needleImage = _load_cv2(needleImage, grayscale) needleHeight, needleWidth = needleImage.shape[:2] haystackImage = _load_cv2(haystackImage, grayscale) if region: > haystackImage = haystackImage[region[1]:region[1]+region[3], region[0]:region[0]+region[2]] E TypeError: slice indices must be integers or None or have an __index__ method C:\tools\miniconda3\envs\rpa2\lib\site-packages\pyscreeze\__init__.py:202: TypeError =========================== short test summary info =========================== FAILED test_iqctrl.py::test_iqcreate - TypeError: slice indices must be integ... ============================== 1 failed in 2.03s ==============================環境

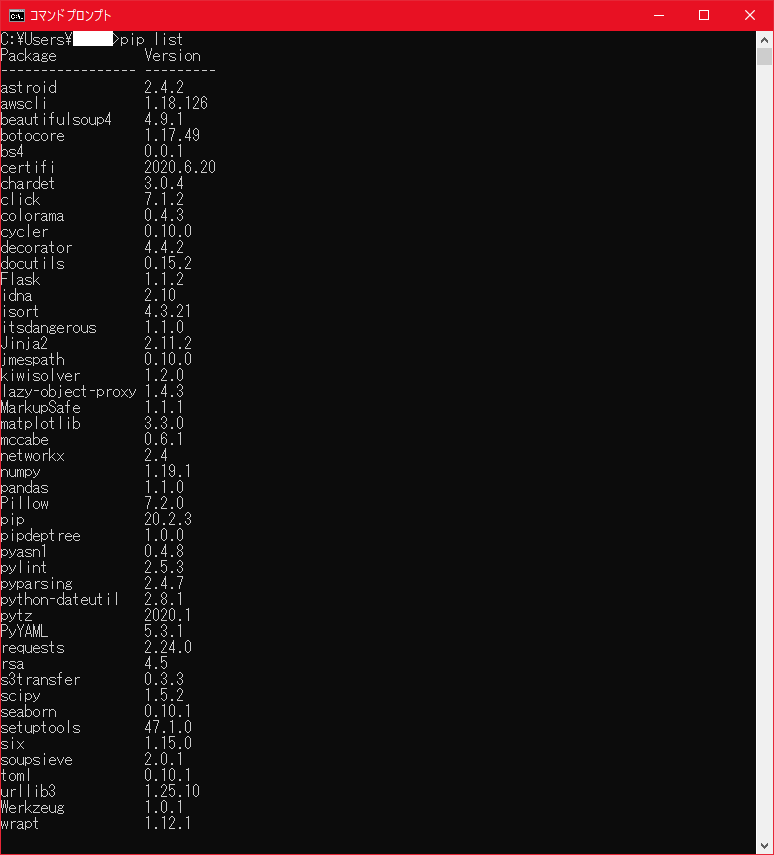

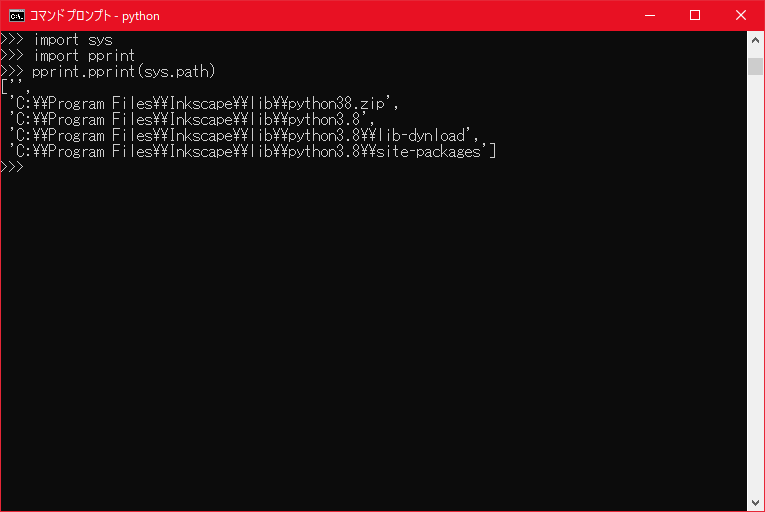

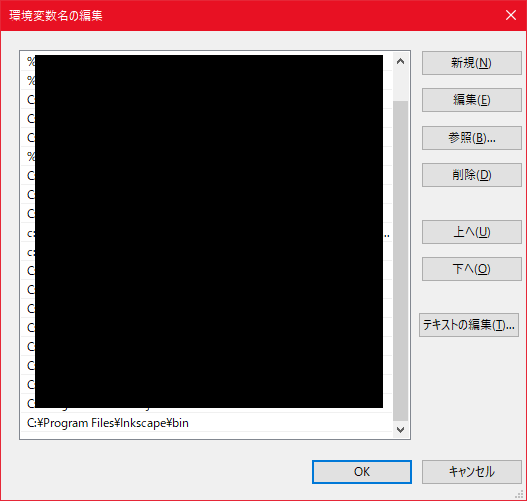

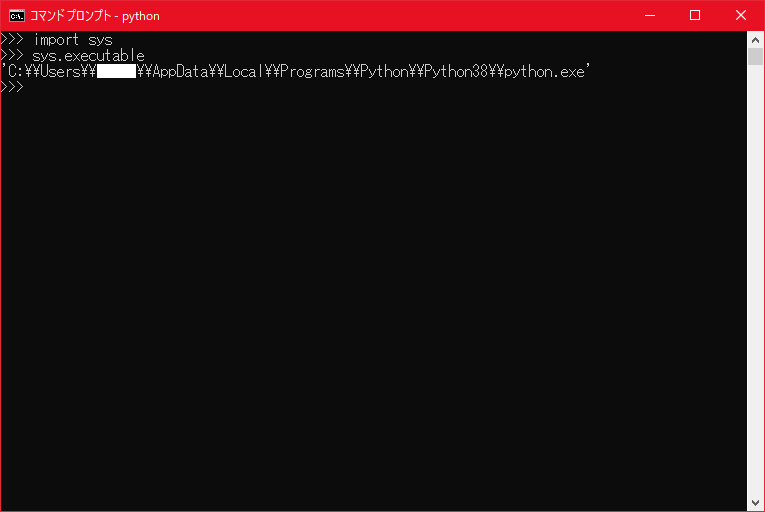

使用しているpythonモジュールの一覧です。

conda install python pip install pyautogui pip install rope yapf black autopep8 pylint pytest pip install tqdm pip install pyperclip pip install pyodbc pip install cx_Oracleここにopencv-pythonを追加しました。

OSはWindows10です。

結論

_locateAll_opencv関数がpython3.xではテストされておらず、発展途上とのこと。

「配列をスライスするインデックスは整数にしなきゃダメだよ」などのエラーが出ていますが、

pyautoguiモジュールの中の話なので関与できませんでした。回避策

現状は2.Xで我慢するか、opencvをあきらめるかどちらか。

どちらも受け入れられない場合にはグレースケールと曖昧画像検索をあきらめる必要がありそう。_locateAll_opencv関数そのものを書き換えられる人は、Githubにプルリクしていただけると助かります。

関係資料

- 投稿日:2020-09-16T16:44:08+09:00

写真から3Dモデルを作る方法を思いついた その04ポリゴンの生成

どーもKsukeです。

写真から3Dモデルを作る方法を思いついたその04で、ポリゴンの生成をやっていきます。

その3はこちらhttps://qiita.com/Ksuke/items/8b7f2dc840126753b4e9※注意※

この記事は思いついて試した事の末路を載せているだけなので、唐突なネタやBad Endで終わる可能性があります。やってみる

手順

1.点群の境界の点を取得

2.点群の境界の内側の点を取得

3.ポリゴン生成ところどころにあるコードは、最後にまとめたものを載せてあります。

1.点群の境界の点を取得

今のところオブジェクトが点群で表されていますが、その点はオブジェクトの内側にも敷き詰められています。内側の点はいらないので、境界部分の点のみを取り出します。

各点が境界かを判定するために、各座標の隣接6方向(上下右左前後)にある点の数を数えます。隣接点の数が0でない点を境界の点として取り出しました。点群の境界の点を取得#境界部分の点群を返す関数 def genBorderPointSpace(imgProjectSpace): # 空間に6方向(上下左右前後)の加算フィルタに相当する処理をして、各地点の周囲の点の数のmapを作る locationPointMap = np.stack([ imgProjectSpace[2:,1:-1,1:-1], imgProjectSpace[:-2,1:-1,1:-1], imgProjectSpace[1:-1,2:,1:-1], imgProjectSpace[1:-1,:-2,1:-1], imgProjectSpace[1:-1,1:-1,2:], imgProjectSpace[1:-1,1:-1,:-2], ]).sum(axis=0,dtype=np.int8) #空間の大きさをもとに戻しておく locationPointMap = np.insert(locationPointMap, (0,-1), 0, axis=0) locationPointMap = np.insert(locationPointMap, (0,-1), 0, axis=1) locationPointMap = np.insert(locationPointMap, (0,-1), 0, axis=2) #各地点ごとの周囲の点の数のmapから、周囲の点の数が0でも6でもない(周囲に点が存在し、かつ点に囲まれていない)点を残した空間を作る borderPointSpace = np.where((0<locationPointMap)&(locationPointMap<6)&(imgProjectSpace==1),1,0).astype(np.int8) #周りを点で囲まれていない点を残した空間を返す return borderPointSpace #重ねた空間の点群のうち、外部と接している境界部分の点を取り出す borderPointSpace = genBorderPointSpace(imgProjectSpace) #空間から点の座標を取り出す borderCoords = binary2coords(borderPointSpace)2.点群の境界の内側の点を取得

ポリゴンの表示は境界部分の点だけで充分ですが、のちのポリゴンの自動生成の都合で、境界の点の内側の点も取得します。

点群の境界の内側の点を取得#境界部分のすぐ内側の点群を返す関数 def genInsidePointSpace(imgProjectSpace,borderPointSpace): #境界付近の点を残した空間を作成(境界部分は残さない) nearBorderPointSpace = np.stack([ borderPointSpace[2:,1:-1,1:-1], borderPointSpace[:-2,1:-1,1:-1], borderPointSpace[1:-1,2:,1:-1], borderPointSpace[1:-1,:-2,1:-1], borderPointSpace[1:-1,1:-1,2:], borderPointSpace[1:-1,1:-1,:-2], borderPointSpace[1:-1,1:-1,1:-1]*-6 ]).sum(axis=0,dtype=np.int8) #大きさを戻す nearBorderPointSpace = np.insert(nearBorderPointSpace, (0,-1), 0, axis=0) nearBorderPointSpace = np.insert(nearBorderPointSpace, (0,-1), 0, axis=1) nearBorderPointSpace = np.insert(nearBorderPointSpace, (0,-1), 0, axis=2) #境界付近で、元の点群の内側の点を残した空間を作成 insidePointSpace = np.where(((0<nearBorderPointSpace)&(imgProjectSpace==1)),1,0) return insidePointSpace #重ねた空間の点群のうち、境界部分のすぐ内側の点を取り出す insidePointSpace = genInsidePointSpace(imgProjectSpace,borderPointSpace) #空間から点の座標を取り出す insideCoords = binary2coords(insidePointSpace)3.ポリゴン生成

2種類の点を取得したら、いよいよポリゴンの生成をしていきます。この処理でやっていることは他の処理に比べ説明しずらいので、2次元の画像で説明します(ここだけめっちゃ時間かかった。。。)。

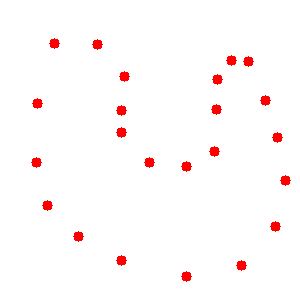

まずこの処理の目的を確認しなおすと、オブジェクトの境界部分の点から、オブジェクトを囲う面を決定することです。2次元の画像上でいうと、オブジェクトの境界部分の点(図1)から領域を囲う線(図2)を決定することになります。

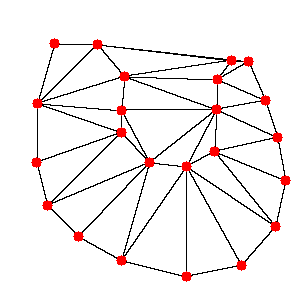

図1.境界部分の点 ↓

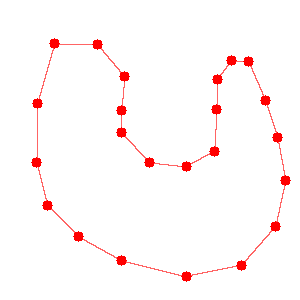

図2.最終的に欲しい境界線 このような処理を行うために、Delaunayというメソッドを利用しました。これは、点で表された領域を三角形で分割する、というものです。画像の赤い点でDelaunayをそのままを試した結果が下の図3です。御覧の通りほしい境界部分に線を引けてはいますが、それ以外の部分にも線が引かれてしまっています。

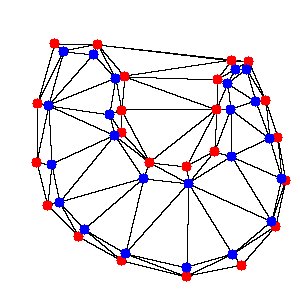

図3.境界部分の点の三角分割結果 さーて困ったと悩んだ末に、境界部分の点とは別に、境界部分の内側の点を加えてDelaunayを行うことにしました。境界部分の内側の点とは、境界部分の点に近く、かつオブジェクトの領域の内側にある点のことです。下の図4でいうところの、追加された青い点です。

図4.境界部分の点と境界部分の内側の点 この境界部分の内側の点を含めてDelaunayをするとどうなるかというと、下の図5のようになります。

図5.境界部分の点と境界部分の内側の点の三角分割結果 一見赤い点だけでDelaunayした時より少し複雑になっただけに見えるかもしれませんが、実はこれなら分割した三角形を3種類に分類することができます。

どう分類するかというと、

・境界部分の点だけで構成された三角形(薄い赤で塗られているもの)

・境界部分の内側の点だけで構成された三角形(薄い青で塗られているもの)

・境界部分の点と境界部分の内側の点両方で構成された三角形(薄い紫で塗られているもの)

という具合です。実際に塗り分けてみると図6のようになります。

図6.三角分割分類結果 3種類の三角形を見てみると、最終的に欲しい境界線はすべて薄い紫の三角形に含まれていることがわかります。そこで薄い紫の三角形以外を除くと図7のようになります。

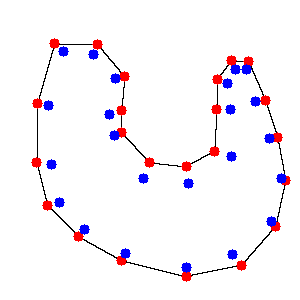

図7.境界線を含む三角形 ここまで三角形が減ったところで、次は線に注目してみていきます。線に注目すると、こちらも3種類に分類することができます。

どう分類するかというと、

・境界部分の点をつないだ線(薄い赤で塗られているもの)

・境界部分の内側の点をつないだ線(薄い青で塗られているもの)

・境界部分の点と境界部分の内側の点をつないだ線(薄い紫で塗られているもの)

という具合です。実際に塗り分けてみると図8のようになります。

図8.線分類結果 ここまでくればあとは見た通りです。薄い赤で塗り分けた線が、まさに図2で書かれた最終的に欲しい境界線そのまんまですよね?てなわけで薄い赤の線以外を除くと図9のようになります。

図9.取得できた境界線 このようにして、点群からそれを囲う線(3次元の点群対象であれば面)を取得することができます。この処理を、3次元の点群を対象として実装したのがこちらです。

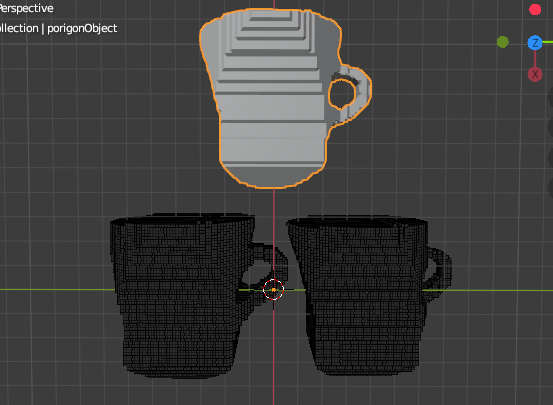

ポリゴン生成#座標群からポリゴンの面を決定する関数 def genPolygon(borderCoords,insideCoords): #2種類の頂点を結合(図4の処理に相当) coords = np.concatenate([borderCoords,insideCoords]) #頂点ごとの種別を表すmapを生成(0はborderで、1はinside) coordStat = np.zeros((len(coords)),dtype=np.uint8) coordStat[len(borderCoords):len(borderCoords)+len(insideCoords)] = 1 #頂点群から4点からなる三角錐群を生成(図5の処理に相当) triPyramids = Delaunay(coords).simplices #三角錐ごとに、insideの頂点がいくつ含まれているか確認(図6の処理に相当) triPyramidsStat = coordStat[triPyramids].sum(axis=1) #三角錐のうち、insideの頂点とborderの頂点を両方含んでいるものを取り出して、有効な三角錐とする(図7の処理に相当) #(ここでborderの頂点のみで構成されたオブジェクトの外部の余白の空間の三角錐と、insideの頂点のみで構成されたオブジェクトの内部の余白の空間の三角錐を取り除く) effectiveTriPyramids = triPyramids[np.where((triPyramidsStat!=0)&(triPyramidsStat!=4))[0]] #オブジェクトの面の候補(頂点のindex3つ)を入れるlist(余分なものは後々取り除く) faces = [] #有効な三角錐の面を、オブジェクトの面の候補をして取り出す(記事の画像の説明でいう、線に注目している部分に該当) for coordIndexs in effectiveTriPyramids: faces.append([coordIndexs[0],coordIndexs[1],coordIndexs[2]]) faces.append([coordIndexs[0],coordIndexs[1],coordIndexs[3]]) faces.append([coordIndexs[0],coordIndexs[2],coordIndexs[3]]) faces.append([coordIndexs[1],coordIndexs[2],coordIndexs[3]]) #オブジェクトの面の候補の、頂点のindexを並び替え、重複を取り除く faces = np.array(faces) faces.sort(axis=1) faces = np.unique(faces,axis=0) #面ごとに、insideの頂点をいくつ含んでいるのか確認(図8の処理に相当) faceStat = coordStat[faces].sum(axis=1) #insideの頂点を1つも含んでいない面を取り出し(図9の処理に相当) faces = faces[np.where(faceStat==0)] #頂点と面を返す return borderCoords,faces #2種類の座標からポリゴン(正確にはポリゴンとなる頂点と頂点を結ぶ面の定義)を生成 coords,faces = genPolygon(borderCoords,insideCoords) #facesをblenderに渡す形式に変更 faces = [[face[0],face[1],face[2],face[0]] for face in faces]動作確認

最後にコードが問題なく動くか確認。

1.全部まとめて

ポリゴン生成のところで力尽きたので動確はまとめて。。。

下のコードをblenderで実行して、動確用1#頂点とポリゴンを描画 addObj(coords=coords,faces=faces,name = "porigon",offset=[-125,-50,-50]) addObj(coords=borderCoords,name = "borderCoords",offset=[-50,-85,-50]) addObj(coords=insideCoords,name = "insideCoords",offset=[-50,-15,-50])こんな感じのオブジェクトが表示されれば成功。オブジェクトのうち下2つをよくよく見比べると、右のほうが少し小さい(境界の内側の点だから)。

次は?

やっとポリゴンが表示されたけど、ポリゴン数がめちゃくちゃ多い・・・。ので、blenderの機能を使ってポリゴン数の削減を行っていきます。

コードまとめ

前回のコードの後ろに追加すれば動くはずです。

関数編

コードまとめ(関数編)#境界部分の点群を返す関数 def genBorderPointSpace(imgProjectSpace): # 空間に6方向(上下左右前後)の加算フィルタに相当する処理をして、各地点の周囲の点の数のmapを作る locationPointMap = np.stack([ imgProjectSpace[2:,1:-1,1:-1], imgProjectSpace[:-2,1:-1,1:-1], imgProjectSpace[1:-1,2:,1:-1], imgProjectSpace[1:-1,:-2,1:-1], imgProjectSpace[1:-1,1:-1,2:], imgProjectSpace[1:-1,1:-1,:-2], ]).sum(axis=0,dtype=np.int8) #空間の大きさをもとに戻しておく locationPointMap = np.insert(locationPointMap, (0,-1), 0, axis=0) locationPointMap = np.insert(locationPointMap, (0,-1), 0, axis=1) locationPointMap = np.insert(locationPointMap, (0,-1), 0, axis=2) #各地点ごとの周囲の点の数のmapから、周囲の点の数が0でも6でもない(周囲に点が存在し、かつ点に囲まれていない)点を残した空間を作る borderPointSpace = np.where((0<locationPointMap)&(locationPointMap<6)&(imgProjectSpace==1),1,0).astype(np.int8) #周りを点で囲まれていない点を残した空間を返す return borderPointSpace #境界部分のすぐ内側の点群を返す関数 def genInsidePointSpace(imgProjectSpace,borderPointSpace): #境界付近の点を残した空間を作成(境界部分は残さない) nearBorderPointSpace = np.stack([ borderPointSpace[2:,1:-1,1:-1], borderPointSpace[:-2,1:-1,1:-1], borderPointSpace[1:-1,2:,1:-1], borderPointSpace[1:-1,:-2,1:-1], borderPointSpace[1:-1,1:-1,2:], borderPointSpace[1:-1,1:-1,:-2], borderPointSpace[1:-1,1:-1,1:-1]*-6 ]).sum(axis=0,dtype=np.int8) #大きさを戻す nearBorderPointSpace = np.insert(nearBorderPointSpace, (0,-1), 0, axis=0) nearBorderPointSpace = np.insert(nearBorderPointSpace, (0,-1), 0, axis=1) nearBorderPointSpace = np.insert(nearBorderPointSpace, (0,-1), 0, axis=2) #境界付近で、元の点群の内側の点を残した空間を作成 insidePointSpace = np.where(((0<nearBorderPointSpace)&(imgProjectSpace==1)),1,0) return insidePointSpace #座標群からポリゴンの面を決定する関数 def genPolygon(borderCoords,insideCoords): #2種類の頂点を結合(図4の処理に相当) coords = np.concatenate([borderCoords,insideCoords]) #頂点ごとの種別を表すmapを生成(0はborderで、1はinside) coordStat = np.zeros((len(coords)),dtype=np.uint8) coordStat[len(borderCoords):len(borderCoords)+len(insideCoords)] = 1 #頂点群から4点からなる三角錐群を生成(図5の処理に相当) triPyramids = Delaunay(coords).simplices #三角錐ごとに、insideの頂点がいくつ含まれているか確認(図6の処理に相当) triPyramidsStat = coordStat[triPyramids].sum(axis=1) #三角錐のうち、insideの頂点とborderの頂点を両方含んでいるものを取り出して、有効な三角錐とする(図7の処理に相当) #(ここでborderの頂点のみで構成されたオブジェクトの外部の余白の空間の三角錐と、insideの頂点のみで構成されたオブジェクトの内部の余白の空間の三角錐を取り除く) effectiveTriPyramids = triPyramids[np.where((triPyramidsStat!=0)&(triPyramidsStat!=4))[0]] #オブジェクトの面の候補(頂点のindex3つ)を入れるlist(余分なものは後々取り除く) faces = [] #有効な三角錐の面を、オブジェクトの面の候補をして取り出す(記事の画像の説明でいう、線に注目している部分に該当) for coordIndexs in effectiveTriPyramids: faces.append([coordIndexs[0],coordIndexs[1],coordIndexs[2]]) faces.append([coordIndexs[0],coordIndexs[1],coordIndexs[3]]) faces.append([coordIndexs[0],coordIndexs[2],coordIndexs[3]]) faces.append([coordIndexs[1],coordIndexs[2],coordIndexs[3]]) #オブジェクトの面の候補の、頂点のindexを並び替え、重複を取り除く faces = np.array(faces) faces.sort(axis=1) faces = np.unique(faces,axis=0) #面ごとに、insideの頂点をいくつ含んでいるのか確認(図8の処理に相当) faceStat = coordStat[faces].sum(axis=1) #insideの頂点を1つも含んでいない面を取り出し(図9の処理に相当) faces = faces[np.where(faceStat==0)] #頂点と面を返す return borderCoords,faces実行コード編

コードまとめ(実行コード編)#重ねた空間の点群のうち、外部と接している境界部分の点を取り出す borderPointSpace = genBorderPointSpace(imgProjectSpace) #重ねた空間の点群のうち、境界部分のすぐ内側の点を取り出す insidePointSpace = genInsidePointSpace(imgProjectSpace,borderPointSpace) #空間から点の座標を取り出す borderCoords = binary2coords(borderPointSpace) insideCoords = binary2coords(insidePointSpace) #2種類の座標からポリゴン(正確にはポリゴンとなる頂点と頂点を結ぶ面の定義)を生成 coords,faces = genPolygon(borderCoords,insideCoords) #facesをblenderに渡す形式に変更 faces = [[face[0],face[1],face[2],face[0]] for face in faces] print("step04:porigon generate success\n") #以下確認表示用(メインの流れと関係ないので、次の回では多分消えてる) #頂点を描画 addObj(coords=coords,faces=faces,name = "porigon",offset=[-125,-50,-50]) addObj(coords=borderCoords,name = "borderCoords",offset=[-50,-85,-50]) addObj(coords=insideCoords,name = "insideCoords",offset=[-50,-15,-50])

- 投稿日:2020-09-16T16:35:37+09:00

Pandas DataFrame を .csv.gz として Amazon S3 に保存する

Pandas DataFrame を gzip 圧縮しつつ CSV ファイルとして Amazon S3 バケットに保存しようとしたときに少しハマったので備忘録。

import gzip from io import BytesIO import pandas as pd import boto3 def save_to_s3(df: pd.DataFrame, bucket: str, key: str): """Pandas DataFrame を .csv.gz として Amazon S3 に保存する""" buf = BytesIO() with gzip.open(buf, mode="wt") as f: df.to_csv(f) s3 = boto3.client("s3") s3.put_object(Bucket=bucket, Key=key, Body=buf.getvalue())ポイントとしては以下。

gzip.openの第一引数は gzip フォーマットを表す file-like オブジェクトなのでBytesIO()を入力するpandas.DataFrame.to_csvの出力は文字列なので、gzip.openのmodeは「テキスト書き込み (wt)」を指定する最初

pandas.DataFrame.to_csvにcompression="gzip"を指定すれば明示的に圧縮しなくてもいけるかと思って試したが、to_csvに file-like オブジェクトを入力した場合はcompressionオプションは無視されるらしく、使えなかった。

- 投稿日:2020-09-16T16:30:51+09:00

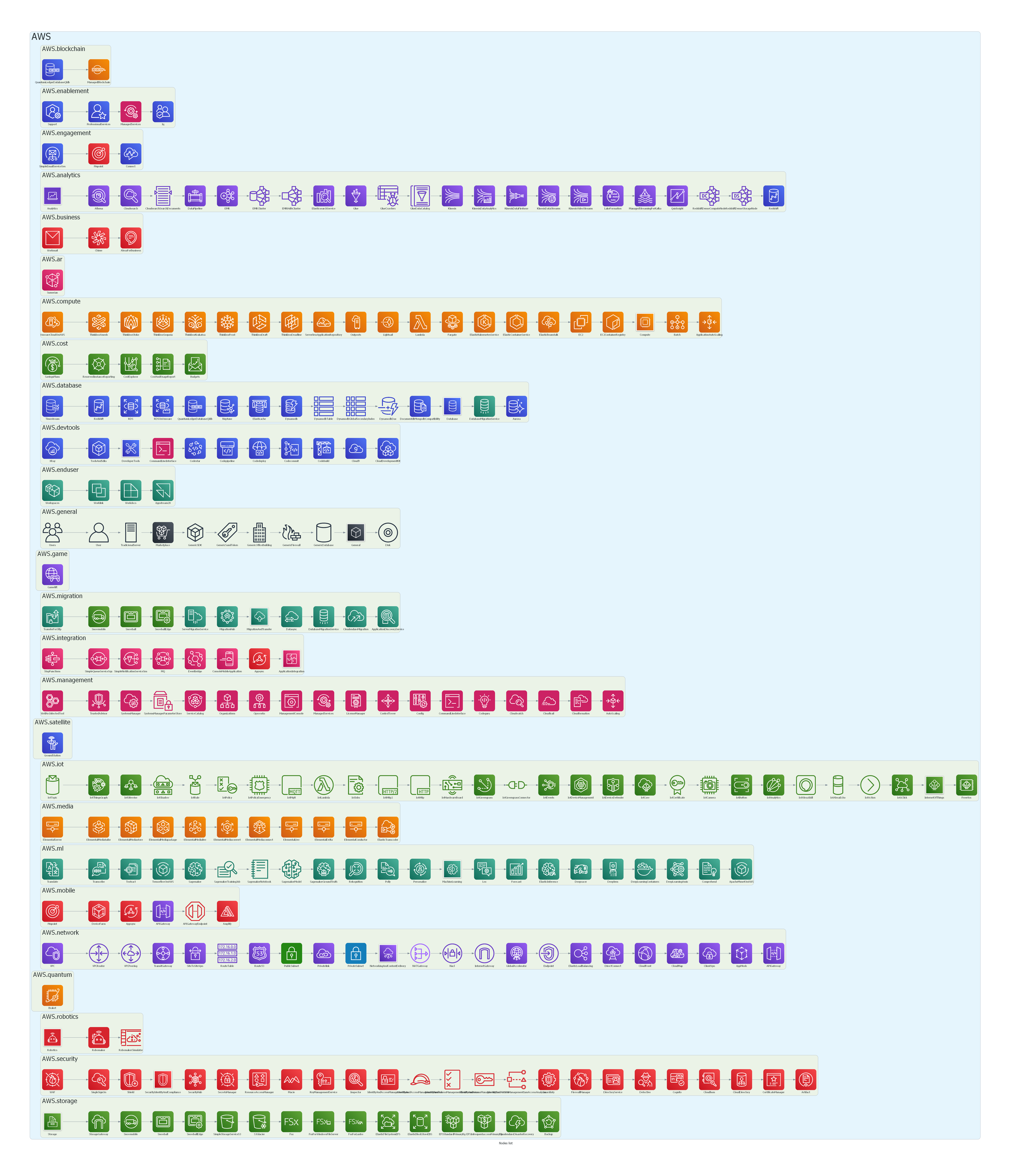

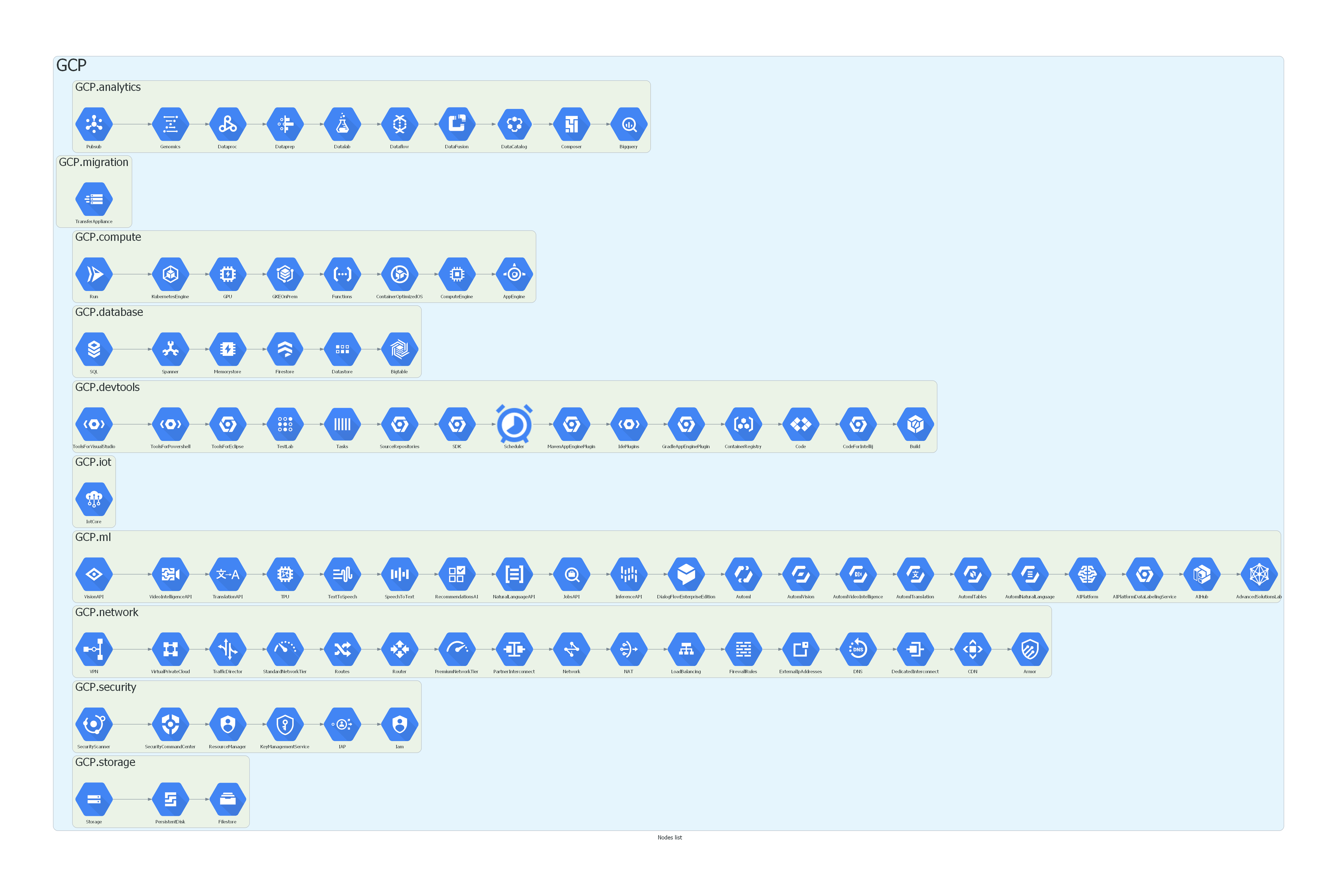

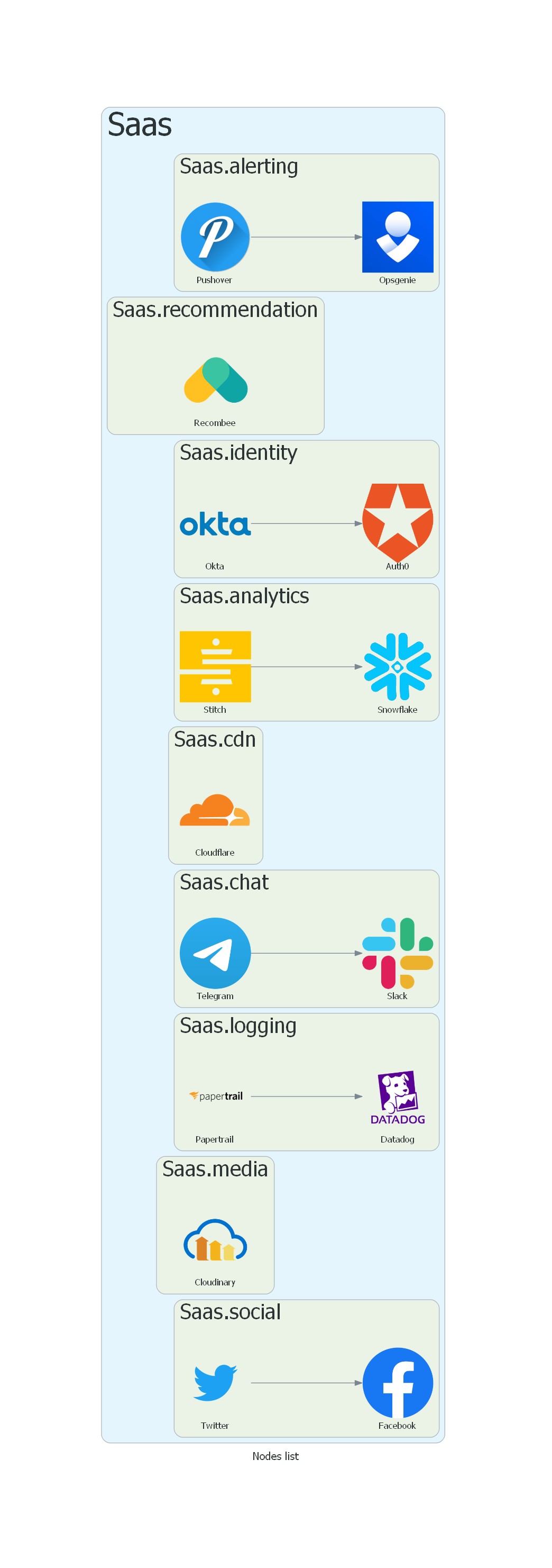

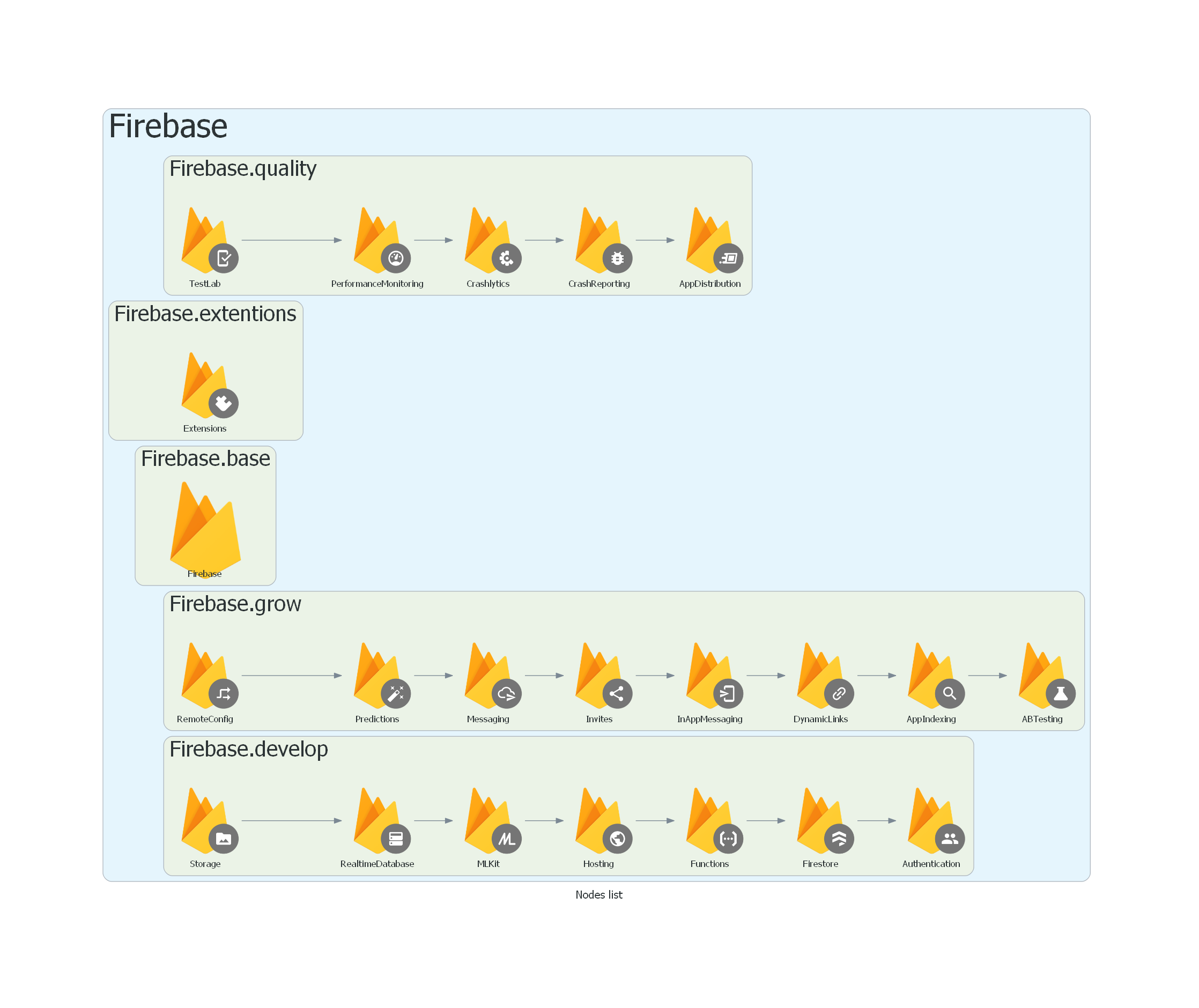

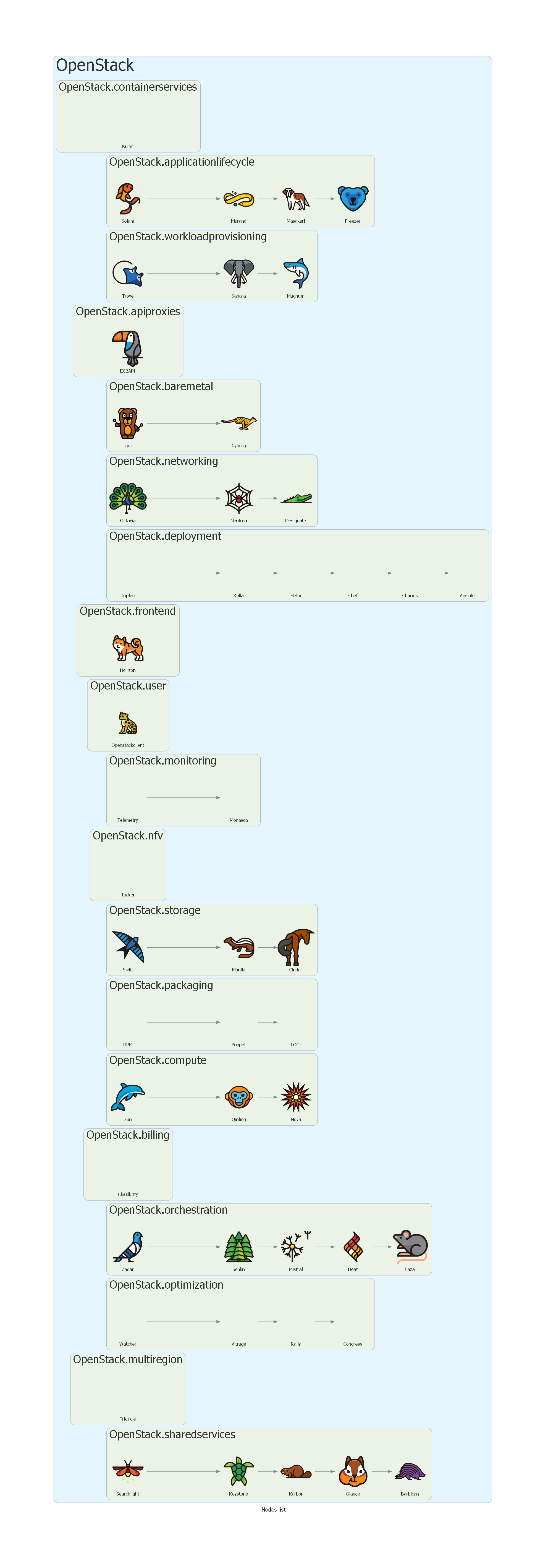

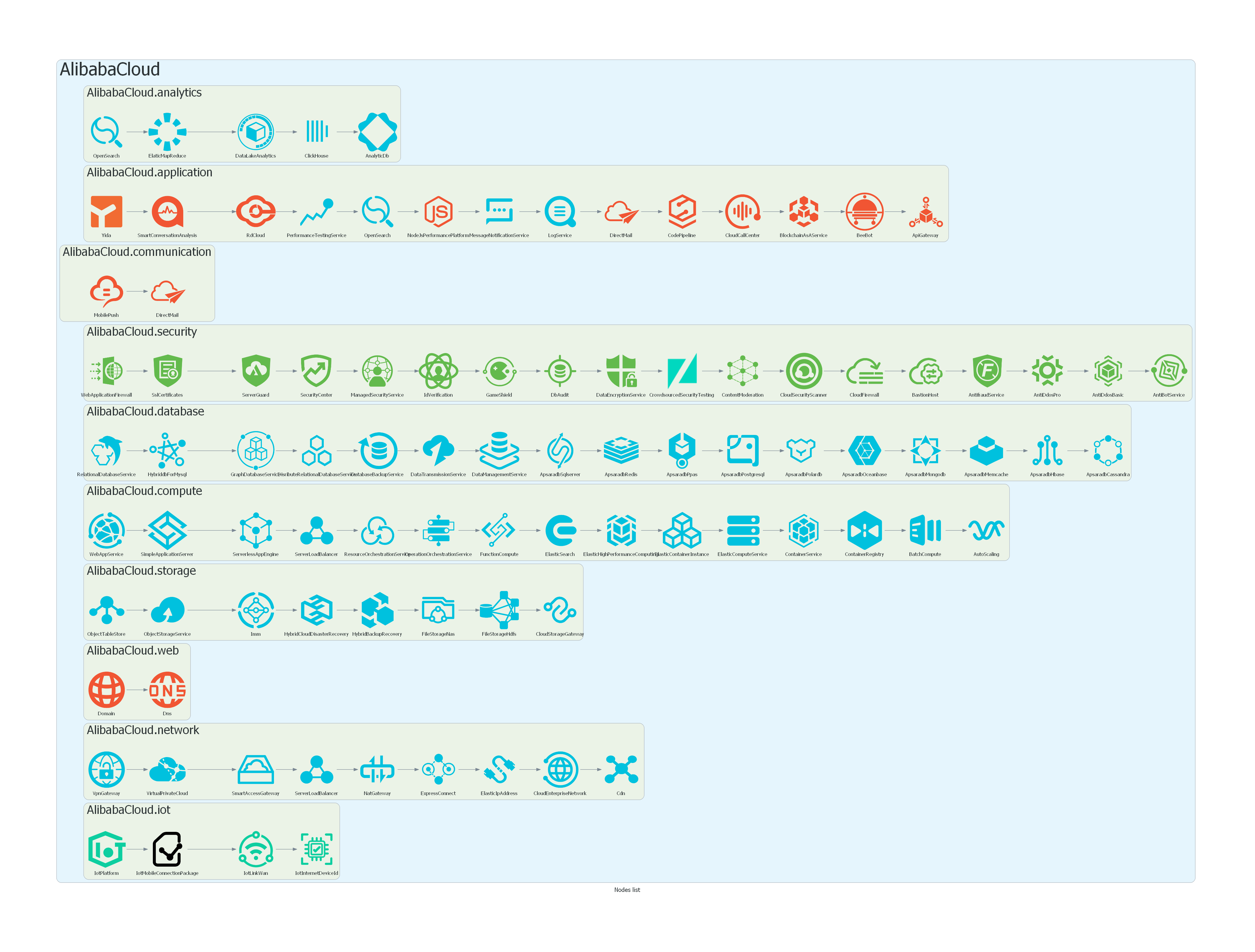

diagrams の nodes の一覧

はじめに

diagrams を使い始めたのですがアイコン画像がよくわからず、一覧を探したところみつからなかったので、自分で一覧を作成しました。

一覧

コード

ココ