- 投稿日:2020-08-06T22:38:35+09:00

【Python】macOSでpipを使えるようにする

ラズパイだと

apt-getでpipがインストールできますが、macOSでpipをインストールしたく、そこで詰まってしまったのでその備忘録です。

Homebrewで一発とか思ってたのですが、brew install pipではインストールできません。1公式ページのインストール方法に従う

公式のやり方に従って、以下のcurlコマンドで

get-pipというPythonファイルがダウンロードします。curl https://bootstrap.pypa.io/get-pip.py -o get-pip.pyダウンロードした

get-pip.pyを実行するとpipがインストールされます。$ python3 get-pip.pyインストール完了

whichコマンドを叩いてパスが表示されるので、インストール自体は完了です。

$ which pip /usr/local/bin/pip環境

- macOS 10.15.5 Catalina

- pip 20.2.1

- Python 3.8.5

参考サイト

※筆者はHomeBrewが大好きです。 ↩

- 投稿日:2020-08-06T22:14:12+09:00

PythonでEDINET・TDNETから有価証券報告書・四半期報告書・決算短信のXBRLをダウンロードする

タイトルがクソ長い..

金融界隈で定量的な分析やデータサイエンスをやっている9uantです.

twitterもやってるので,興味ある方はぜひフォローしていただけると!タイトルの通り,決算書類のXBRLを手早くダウンロードするためのコードを共有する.

解説も追々書いていきたい.

以下の2ステップをとる.

- XBRLへのリンクをDataFrame化する

- DataFrameからXBRLのzipファイルをダウンロードする

import os import glob import shutil import re import time from datetime import date, timedelta, datetime from dateutil.relativedelta import relativedelta import requests from bs4 import BeautifulSoup import urllib3 from urllib3.exceptions import InsecureRequestWarning urllib3.disable_warnings(InsecureRequestWarning) from selenium import webdriver from selenium.webdriver.common.keys import Keys from selenium.webdriver.support.ui import Select from selenium.webdriver.common.by import By import zipfile import numpy as np import pandas as pd import jsonXBRLへのリンクをDataFrame化する

EDINET

EDINETにはAPIが存在するため容易.

def edinet_xbrl_link(annual=True, quarter=True, codes=None, year=0,month=0,day=0): ''' 特定の企業の,もしくは全ての有価証券報告書・四半期報告書のXBRLのリンクのDataFrameを作成する Parameters: annual: bool, default True True の場合に有価証券報告書を取得する quarter: bool, default Ture True の場合に四半期報告書を取得する codes: None, int, float, str, or list (codes[code]=int, float,or str), default None None の場合に全ての企業のデータを取得する 銘柄コードを指定すると,それらの企業のデータのみを取得する:point_up_tone4: year, month, day: int, default 0 現在から何日前までのデータを取得するかを指定する(最大5年) Returns: database: pandas.DataFrame database['code']: str 5桁の証券コード database['type']: str 'annual' or 'quarter' database['date']: datetime.date 公開日 database['title']: str 表題 database['URL']: str XBRLのzipファイルをダウンロードするURL ''' edinet_url = "https://disclosure.edinet-fsa.go.jp/api/v1/documents.json" # codesを文字型の配列に統一する. if codes != None: if type(codes) in (str, int, float): codes = [int(codes)] for code in codes: # 4桁の証券コードを5桁に変換 if len(str(int(code)))==4: code = str(int(code))+'0' # datetime型でfor文を回す def date_range(start, stop, step = timedelta(1)): current = start while current < stop: yield current current += step # 結果を格納するDataFrameを用意 database = pd.DataFrame(index=[], columns=['code','type','date','title','URL']) for d in date_range(date.today()-relativedelta(years=year, months=month, days=day)+relativedelta(days=1), date.today()+relativedelta(days=1)): # EDINET API にアクセス d_str = d.strftime('%Y-%m-%d') params = {'date' : d_str, 'type' : 2} res = requests.get(edinet_url, params=params, verify=False) json_res = json.loads(res.text) time.sleep(5) # 正常にアクセスできない場合 if json_res['metadata']['status']!='200': print(d_str, 'not accessible') continue print(d_str, json_res['metadata']['resultset']['count'])# 日付と件数を表示 # 0件の場合 if len(json_res['results'])==0: continue df = pd.DataFrame(json_res['results'])[['docID', 'secCode', 'ordinanceCode', 'formCode','docDescription']] df.dropna(subset=['docID'], inplace=True) df.dropna(subset=['secCode'], inplace=True) df.rename(columns={'secCode': 'code', 'docDescription': 'title'}, inplace=True) df['date'] = d df['URL'] = df['docID'] df['URL'] = "https://disclosure.edinet-fsa.go.jp/api/v1/documents/" + df['URL'] # 指定された証券コードのみを抽出 if codes != None: df = df[df['code'] in codes] if annual == True: df1 = df[(df['ordinanceCode']=='010') & (df['formCode']=='030000')] df1['type'] = 'annual' database = pd.concat([database, df1[['code', 'type', 'date','title', 'URL']]], axis=0, join='outer').reset_index(drop=True) if quarter == True: df2 = df[(df['ordinanceCode']=='010') & (df['formCode']=='043000')] df2['type'] = 'quarter' database = pd.concat([database, df2[['code', 'type', 'date','title', 'URL']]], axis=0, join='outer').reset_index(drop=True) return databaseTDNET

TDNETからのデータの収集には

seleniumを用いる.

フリーワード検索結果が200件までしか表示されないため,証券コードから検索する関数と,日付から検索する関数を別々に作成した.def tdnet_xbrl_link_by_code(codes): ''' 指定された企業の決算短信をXBRLへのリンクのDataFrameを作成する Parameters: codes: None, int, float, str, or list (codes[code]=int, float,or str), default None None の場合に全ての企業のデータを取得する Returns: database: pandas.DataFrame database['code']: str 5桁の証券コード database['type']: str 'annual' or 'quarter' database['date']: datetime.date 公開日 database['title']: str 表題 database['URL']: str XBRLのzipファイルをダウンロードするURL ''' # codesを文字型の配列に統一する. if type(codes) in (str, int, float): codes = [int(codes)] for i, code in enumerate(codes): # 4桁の証券コードを5桁に変換 if len(str(int(code)))==4: codes[i] = str(int(code))+'0' database = pd.DataFrame(index=[], columns=['code','type','date','title','URL']) for code in codes: # ブラウザを起動する chromeOptions = webdriver.ChromeOptions() chromeOptions.add_argument('--headless') # ブラウザ非表示 driver = webdriver.Chrome(options=chromeOptions) driver.get("https://www.release.tdnet.info/onsf/TDJFSearch/I_head") # 検索ワードを送る duration = driver.find_element_by_name('t0') select = Select(duration) select.options[-1].click() inputElement = driver.find_element_by_id("freewordtxt") inputElement.send_keys(code) inputElement.send_keys(Keys.RETURN) time.sleep(5) # 検索結果が表示されたフレームに移動 iframe = driver.find_element_by_name("mainlist") driver.switch_to.frame(iframe) # 検索結果が0件の場合に処理を終える if driver.find_element_by_id("contentwrapper").text == '該当する適時開示情報が見つかりませんでした。': return database # 検索結果の表の各行からデータを読み取る table = driver.find_element_by_id("maintable") trs = table.find_elements(By.TAG_NAME, "tr") for i in range(len(trs)): title = trs[i].find_elements(By.TAG_NAME, "td")[3].text # 訂正書類でなく,XBRLが存在する,指定された企業の決算短信を選択 if ('決算短信' in title) and ('訂正' not in title) and (len(trs[i].find_elements(By.TAG_NAME, "td")[4].text)!=0) and (code==trs[i].find_elements(By.TAG_NAME, "td")[1].text): date = trs[i].find_elements(By.TAG_NAME, "td")[0].text[:10] date = datetime.strptime(date, '%Y/%m/%d').date() url = trs[i].find_elements(By.TAG_NAME, "td")[4].find_element_by_tag_name("a").get_attribute("href") database = database.append(pd.Series([code,'brief',date,title,url], index=database.columns), ignore_index=True) driver.quit() return databasedef tdnet_xbrl_link_by_date(date=None): ''' 指定された日付,もしくは全ての決算短信をXBRLへのリンクのDataFrameを作成する Parameters: date: None or str ('yyyy/mm/dd'), default None None の場合に全ての日付のデータを取得する Returns: database: pandas.DataFrame database['code']: str 5桁の証券コード database['type']: str 'annual' or 'quarter' database['date']: datetime.date 公開日 database['title']: str 表題 database['URL']: str XBRLのzipファイルをダウンロードするURL ''' database = pd.DataFrame(index=[], columns=['code','type','date','title','URL']) # ブラウザを起動する chromeOptions = webdriver.ChromeOptions() chromeOptions.add_argument('--headless') # ブラウザ非表示 driver = webdriver.Chrome(options=chromeOptions) driver.get("https://www.release.tdnet.info/inbs/I_main_00.html") duration = driver.find_element_by_name('daylist') select = Select(duration) for i in range(1, len(select.options)): driver.get("https://www.release.tdnet.info/inbs/I_main_00.html") duration = driver.find_element_by_name('daylist') select = Select(duration) d = datetime.strptime(select.options[i].text[:10], '%Y/%m/%d').date() print(select.options[i].text) if (date == None) or (date == select.options[i].text[:10]): select.options[i].click() time.sleep(5) # 検索結果が表示されたフレームに移動 iframe = driver.find_element_by_id("main_list") driver.switch_to.frame(iframe) # 検索結果が0件の場合に処理を終える if driver.find_element_by_id("kaiji-text-1").text!='に開示された情報': continue # 最後のページまで処理を続ける while True: # 検索結果の表の各行からデータを読み取る table = driver.find_element_by_id("main-list-table") trs = table.find_elements(By.TAG_NAME, "tr") for i in range(len(trs)): title = trs[i].find_elements(By.TAG_NAME, "td")[3].text # 訂正書類でなく,XBRLが存在する,指定された企業の決算短信を選択 if ('決算短信' in title) and ('訂正' not in title) and (len(trs[i].find_elements(By.TAG_NAME, "td")[4].text)!=0): code = trs[i].find_elements(By.TAG_NAME, "td")[1].text url = trs[i].find_elements(By.TAG_NAME, "td")[4].find_element_by_tag_name("a").get_attribute("href") database = database.append(pd.Series([code, 'brief', d, title,url], index=database.columns), ignore_index=True) if len(driver.find_element_by_class_name("pager-R").text)!=0: driver.find_element_by_class_name("pager-R").click() time.sleep(5) else: # 「次へ」の文字が存在しない場合に処理を終了する break driver.quit() return databaseDataFrameからXBRLをダウンロードする

def dl_xbrl_zip(codes=None, database): ''' XBRLへのリンクをリスト化したDataFrameを参照して,XBRLのzipファイルをダウンロードする Parameters: codes: None, int, float, str, or list (codes[code]=int, float,or str), default None None の場合に全ての企業のXBRLを取得する database: pandas.DataFrame database['code']: str 5桁の証券コード database['type']: str 'annual' or 'quarter' database['date']: datetime.date 公開日 database['title']: str 表題 database['URL']: str XBRLのzipファイルをダウンロードするURL Returns: None ''' database.dropna(subset=['code'], inplace=True) database = database.reset_index(drop=True) # codesを文字型の配列に統一する if codes == None: codes = [None] else: if type(codes) in (str, int, float): codes = [int(codes)] for i, code in enumerate(codes): # 4桁の証券コードを5桁に変換 if len(str(int(code)))==4: codes[i] = str(int(code))+'0' for code in codes: if code == None: df_company = database else: df_company = database[database['code']==code] df_company = df_company.reset_index(drop=True) # 証券コードをディレクトリ名とする dir_path = database.loc[i,'code'] if os.path.exists(dir_path)==False: os.mkdir(dir_path) # 抽出したリストの各行からXBRLへのリンクからzipファイルをダウンロード for i in range(df_company.shape[0]): # EDINETへアクセスする場合 if (df_company.loc[i,'type'] == 'annual') or (df_company.loc[i,'type'] == 'quarter'): params = {"type": 1} res = requests.get(df_company.loc[i,'URL'], params=params, stream=True) if df_company.loc[i,'type'] == 'annual': # 有価証券報告書のファイル名は"yyyy_0.zip" filename = dir_path + r'/' + df_company.loc[i,'date'][:4] + r"_0.zip" elif df_company.loc[i,'type'] == 'quarter': if re.search('期第', df_company.loc[i,'title']) == None: # 第何期か不明の四半期報告書のファイル名は"yyyy_unknown_docID.zip" filename = dir_path + r'/' + df_company.loc[i,'date'][:4] + r'_unknown_' + df_company.loc[i,'URL'][-8:] + r'.zip' else: # 四半期報告書のファイル名は"yyyy_quarter.zip" filename = dir_path + r'/' + df_company.loc[i,'date'][:4] + r'_' + df_company.loc[i,'title'][re.search('期第', df_company.loc[i,'title']).end()] + r'.zip' # TDNETへアクセスする場合 elif df_company.loc[i,'type'] == 'brief': res = requests.get(df_company.loc[i,'URL'], stream=True) # 空白文字を埋める s_list = df_company.loc[i,'title'].split() s = '' for i in s_list: s += i filename = df_company.loc[i,'date'][:4] + r'_' + s[re.search('期第', s).end()] + r'_brief.zip' # 同名のzipファイルが存在する場合,上書きはしない if os.path.exists(filename): print(df_company.loc[i,'code'],df_company.loc[i,'date'],'already exists') continue # 正常にアクセスできた場合のみzipファイルをダウンロード if res.status_code == 200: with open(filename, 'wb') as file: for chunk in res.iter_content(chunk_size=1024): file.write(chunk) print(df_company.loc[i,'code'],df_company.loc[i,'date'],'saved') print('done!') return None

- 投稿日:2020-08-06T21:55:08+09:00

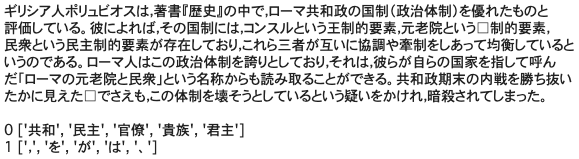

Computer Vision : Semantic Segmentation Part1 - ImageNet pretraining VoVNet

目標

Microsoft Cognitive Toolkit (CNTK) を用いたセマンティックセグメンテーションについてまとめました。

Part1 では、セマンティックセグメンテーションのためのバックボーンに使用する CNN の事前学習を行います。

CNN の事前学習には 1,000カテゴリーの ImageNet の画像を使用します。以下の順で紹介します。

- ImageNet からのダウンロードと準備

- VoVNet : One-Shot Aggregation module

- 訓練における諸設定

導入

ImageNet からのダウンロードと準備

ImageNet [1] は 1.4億枚以上の画像が登録されている大規模な画像データベースです。2017年までは画像認識のコンペティション ILSVCR に使われていました。

今回は ImageNet が管理している画像の URL を使ってダウンロードする方法で 1,000カテゴリーの訓練データを収集しました。ただし、850番目の teddy, teddy bear は一枚もダウンロードできなかったため、Computer Vision : Image Classification Part1 - Understanding COCO dataset で準備した画像で代用しました。

また、ダウンロードした画像には壊れた JPEG ファイルやカテゴリーとは関係のない画像も相当数含まれていたので、自動と手動でクリーニングしました。最終的に収集できた画像は 775,983枚になりました。

今回のディレクトリの構成は以下のようにしました。

COCO

MNIST

NICS

RTSS

|―ImageNet

|―n01440764

|―n01440764_0.jpg

|―…

rtss_imagenet.py

rtss_vovnet57.py

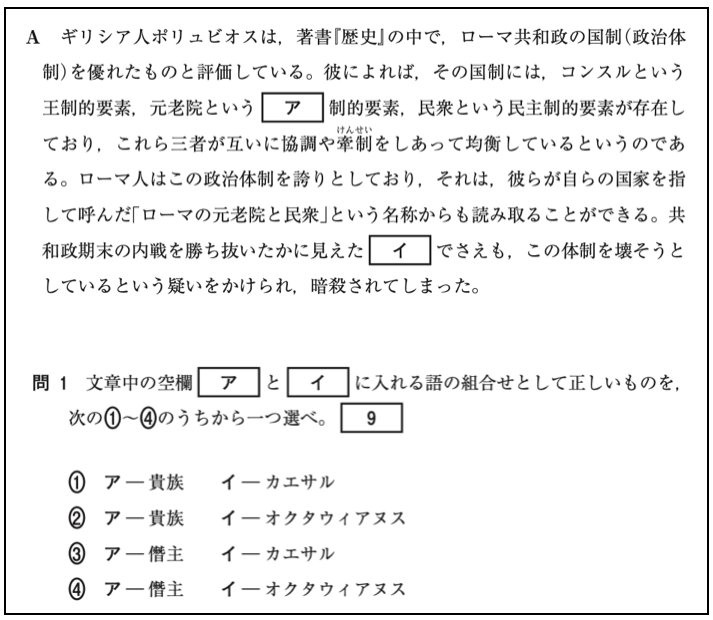

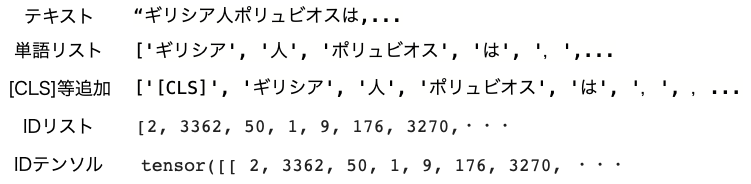

SSMDVoVNet : One-Shot Aggregation module

畳み込みニューラルネットワークのモデルとして、今回は VoVNet [2] (Variety of View Network) を採用しました。VoVNet は DenseNet [3] よりもメモリ使用量と計算コストを削減した CNN モデルです。

One-Shot Aggregation module

VoVNet では、下図の四角で囲まれた One-Shot Aggregation (OSA) モジュールを使用します。

VoVNet57

VoVNet57 のネットワークの構成は以下のようになっています。

Layer Filters Size/Stride Input Output Convolution2D 64 3x3/2 3x224x224 64x112x112 Convolution2D 64 3x3/1 64x112x112 64x112x112 Convolution2D 128 3x3/1 64x112x112 128x112x112 MaxPooling2D 3x3/2 128x112x112 128x56x56 OSA module 128, 256 3x3/1, 1x1/1 128x56x56 256x56x56 MaxPooling2D 3x3/2 256x56x56 256x28x28 OSA module 160, 512 3x3/1, 1x1/1 256x28x28 512x28x28 MaxPooling2D 3x3/2 512x28x28 512x14x14 OSA module 192, 768 3x3/1, 1x1/1 512x14x14 768x14x14 OSA module 192, 768 3x3/1, 1x1/1 768x14x14 768x14x14 OSA module 192, 768 3x3/1, 1x1/1 768x14x14 768x14x14 OSA module 192, 768 3x3/1, 1x1/1 768x14x14 768x14x14 MaxPooling2D 3x3/2 768x14x14 768x7x7 OSA module 224, 1024 3x3/1, 1x1/1 768x7x7 1024x7x7 OSA module 224, 1024 3x3/1, 1x1/1 1024x7x7 1024x7x7 OSA module 224, 1024 3x3/1, 1x1/1 1024x7x7 1024x7x7 GlobalAveragePooling global 1024x7x7 1024x1x1 Dense 1000 1024x1x1 1000x1x1 Softmax 1000 1000 1000 合計 57層の畳み込みと 32倍のダウンサンプリングで構成されます。パラメータの総数は 31,429,159 です。

畳み込み層ではバイアスを使用せずに、Batch Normalization [4] を適用してから活性化関数へ入力します。

最後の全結合層では、Batch Normalization は使用せずにバイアス項を使用します。

活性化関数 Mish

活性化関数には Mish [5] を採用しました。Mish は ReLU を上回る Swish [6] よりも高い性能が報告されている活性化関数です。Mish は以下の式で表されるように、ソフトプラス関数と tanh関数を組み合わせることで簡単に実装できます。

Mish(x) = x \cdot \tanh \left( \log (1 + e^x) \right)Mish は下図のようになります。

Mish は ReLU の deadly neuron を回避し、ReLU が微分すると不連続なのに対して Mish は何度微分しても連続なので、損失関数が滑らかになって最適化しやすくなります。

訓練における諸設定

入力画像は輝度値の最大値 255 で除算します。

各層のパラメータの初期値は He の正規分布 [7] に設定しました。

損失関数は Cross Entropy Error、最適化アルゴリズムは Stochastic Gradient Decent (SGD) with Momentum を採用しました。モーメンタムは 0.9 に固定しました。

学習率には、Cyclical Learning Rate (CLR) [8] を採用し、最大学習率は 0.1、ベース学習率は 1e-4、ステップサイズはエポック数の 10倍、方策は triangular2 に設定しました。

過学習対策として、L2 正則化の値を 0.0005 に設定しました。

モデルの訓練はミニバッチサイズ 64 のミニバッチ学習によって 100 Epoch を実行しました。

実装

実行環境

ハードウェア

・CPU Intel(R) Core(TM) i7-5820K 3.30GHz

・GPU NVIDIA Quadro RTX 5000 16GBソフトウェア

・Windows 10 Pro 1909

・CUDA 10.0

・cuDNN 7.6

・Python 3.6.6

・cntk-gpu 2.7

・cntkx 0.1.50

・numpy 1.17.3

・opencv-contrib-python 4.1.1.26

・pandas 0.25.0

・requests 2.22.0実行するプログラム

ImageNet からダウンロードするプログラムと訓練用のプログラムは GitHub で公開しています。

rtss_imagenet.pyrtss_vovnet57.py結果

訓練時の損失関数と誤認識率のログを可視化したものが下図です。左のグラフが損失関数、右のグラフが誤認識率になっており、横軸はエポック数、縦軸はそれぞれ損失関数の値と誤認識率を表しています。

これでバックボーンとなる CNN 事前学習モデルができたので、Part2 ではセマンティックセグメンテーションを実現するための機構を加えて完成させます。

参考

ImageNet

Microsoft COCO Common Objects in ContextComputer Vision : Image Classification Part1 - Understanding COCO dataset

- Jia Deng, Wei Dong, Richard Socher, Li-Jia Li, Kai Li, and Li Fei-Fei. "ImageNet: A Large-Scale Hierarchical Image Database", IEEE conference on Computer Vision and Pattern Recognition (CVPR). 2009, p. 248-255.

- Youngwan Lee, Joong-won Hwang, Sangrok Lee, Yuseok Bae, and Jongyoul Park. "An Energy and GPU-Computation Efficient Backbone Network for Real-Time Object Detection", the IEEE Conference on Computer Vision and Pattern Recognition Workshops. 2019, p. 0-0.

- Gao Huang, Zhuang Liu, Laurens van der Maaten, and Kilian Q. Weinberger. "Densely Connected Convolutional Networks", the IEEE conference on Computer Vision and Pattern Recognition (CVPR). 2017. p. 4700-4708.

- Ioffe Sergey and Christian Szegedy. "Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift", arXiv preprint arXiv:1502.03167 (2015).

- Misra, Diganta. "Mish: A self regularized non-monotonic neural activation function." arXiv preprint arXiv:1908.08681 (2019).

- Ramachandran, Prajit, Barret Zoph, and Quoc V. Le. "Searching for activation functions." arXiv preprint arXiv:1710.05941 (2017).

- Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun. "Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification", The IEEE International Conference on Computer Vision (ICCV). 2015, p. 1026-1034.

- Leslie N. Smith. "Cyclical Learning Rates for Training Neural Networks", 2017 IEEE Winter Conference on Applications of Computer Vision. 2017, p. 464-472.

- 投稿日:2020-08-06T21:47:47+09:00

3.PythonによるAIプログライミング

はじめに

いきなりこのページに来られた方は、

親ページから参照をお願いいたします。ここの目的

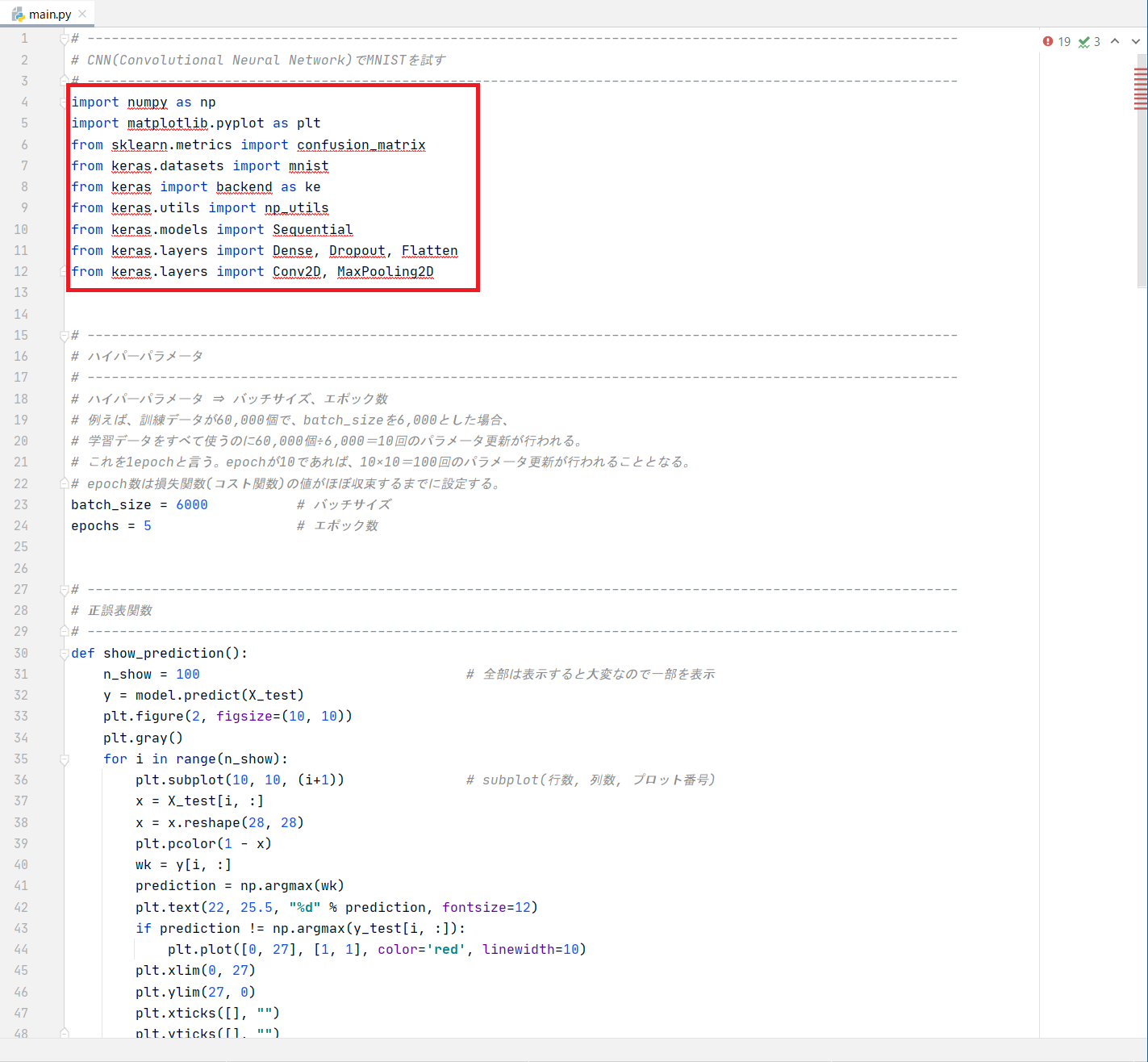

pycharmを使用して、python言語でAIをコーディングします。コードはコピペでOKです。

ソースコード内の意味が分からなくても実行できます。開発環境の立ち上げ

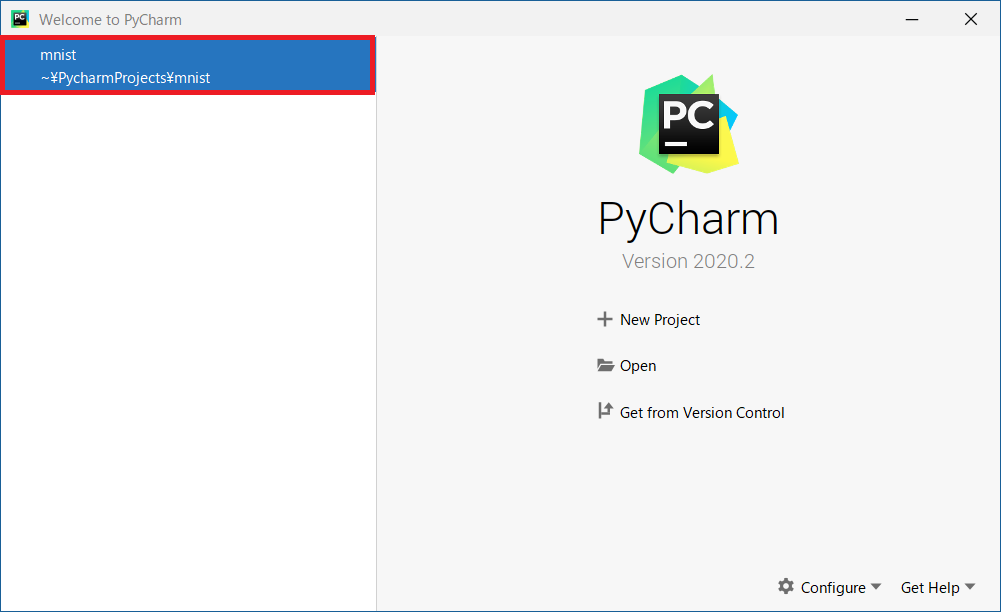

Pythonプログラムを作成するためにpycharm(PyCharm Community Edition)を起動します。前回作ったPJが表示されるので「

mnist」をクリック

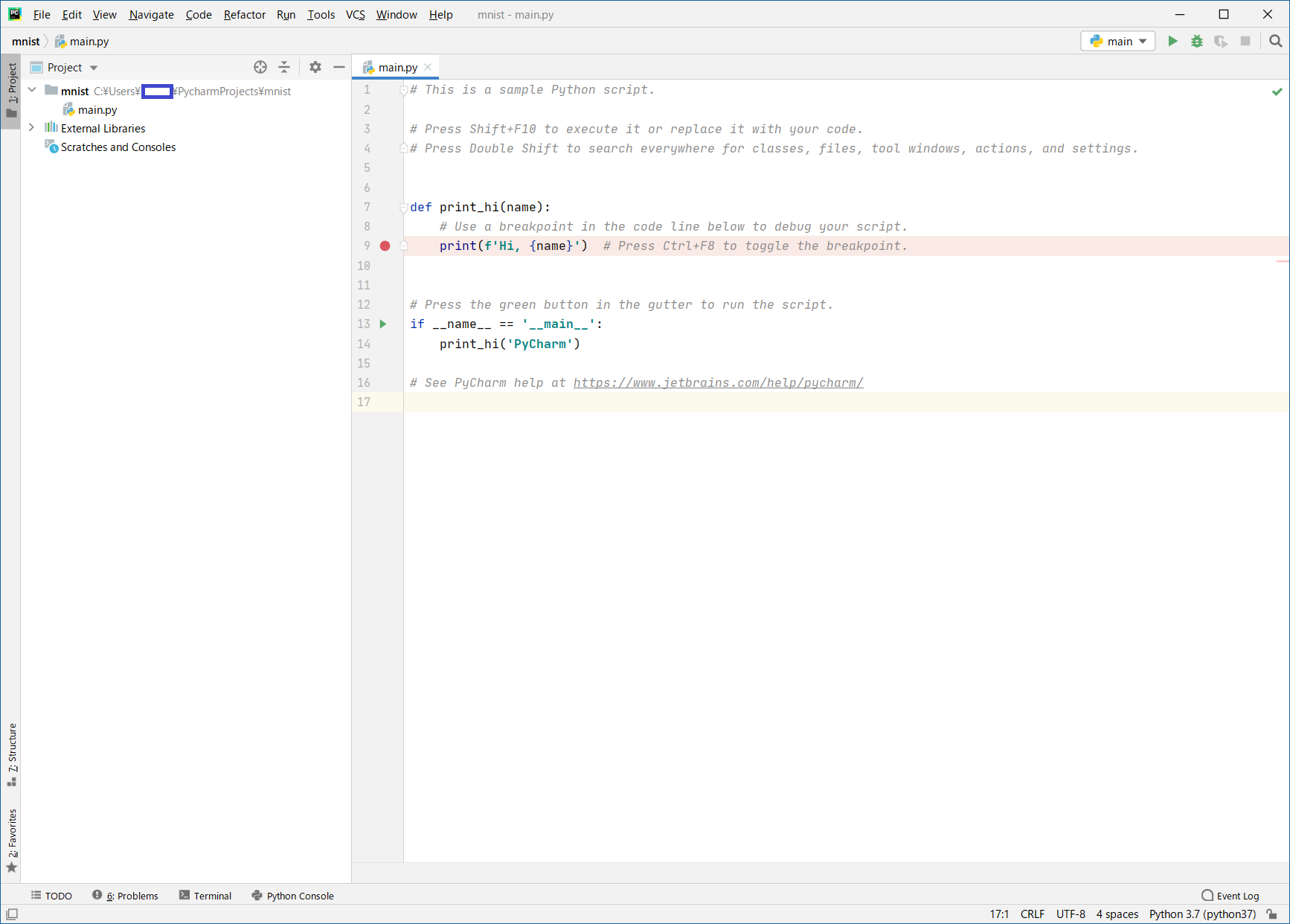

このサンプルのソースコードは、AIとは全く関係がないものなので全部消去します (サンプルのソースコードは、

CTL+AしてDELキーで簡単に消せます)

PythonによるAIプログラミング

- ソースコードは以下です。

main.py# ------------------------------------------------------------------------------------------------------------ # CNN(Convolutional Neural Network)でMNISTを試す # ------------------------------------------------------------------------------------------------------------ import numpy as np import matplotlib.pyplot as plt from sklearn.metrics import confusion_matrix from keras.datasets import mnist from keras import backend as ke from keras.utils import np_utils from keras.models import Sequential from keras.layers import Dense, Dropout, Flatten from keras.layers import Conv2D, MaxPooling2D # ------------------------------------------------------------------------------------------------------------ # ハイパーパラメータ # ------------------------------------------------------------------------------------------------------------ # ハイパーパラメータ ⇒ バッチサイズ、エポック数 # 例えば、訓練データが60,000個で、batch_sizeを6,000とした場合、 # 学習データをすべて使うのに60,000個÷6,000=10回のパラメータ更新が行われる。 # これを1epochと言う。epochが10であれば、10×10=100回のパラメータ更新が行われることとなる。 # epoch数は損失関数(コスト関数)の値がほぼ収束するまでに設定する。 batch_size = 6000 # バッチサイズ epochs = 5 # エポック数 # ------------------------------------------------------------------------------------------------------------ # 正誤表関数 # ------------------------------------------------------------------------------------------------------------ def show_prediction(): n_show = 100 # 全部は表示すると大変なので一部を表示 y = model.predict(X_test) plt.figure(2, figsize=(10, 10)) plt.gray() for i in range(n_show): plt.subplot(10, 10, (i+1)) # subplot(行数, 列数, プロット番号) x = X_test[i, :] x = x.reshape(28, 28) plt.pcolor(1 - x) wk = y[i, :] prediction = np.argmax(wk) plt.text(22, 25.5, "%d" % prediction, fontsize=12) if prediction != np.argmax(y_test[i, :]): plt.plot([0, 27], [1, 1], color='red', linewidth=10) plt.xlim(0, 27) plt.ylim(27, 0) plt.xticks([], "") plt.yticks([], "") # ------------------------------------------------------------------------------------------------------------ # keras backendの表示 # ------------------------------------------------------------------------------------------------------------ # print(ke.backend()) # print(ke.floatx()) # ------------------------------------------------------------------------------------------------------------ # MNISTデータの取得 # ------------------------------------------------------------------------------------------------------------ # 初回はダウンロードが発生するため時間がかかる # 60,000枚の28x28ドットで表現される10個の数字の白黒画像と10,000枚のテスト用画像データセット # ダウンロード場所:'~/.keras/datasets/' # ※MNISTのデータダウンロードがNGとなる場合は、PROXYの設定を見直してください # # MNISTデータ # ├ 教師データ (60,000個) # │ ├ 画像データ # │ └ ラベルデータ # │ # └ 検証データ (10,000個) # ├ 画像データ # └ ラベルデータ # ↓教師データ ↓検証データ (X_train, y_train), (X_test, y_test) = mnist.load_data() # ↑画像 ↑ラベル ↑画像 ↑ラベル # ------------------------------------------------------------------------------------------------------------ # 画像データ(教師データ、検証データ)のリシェイプ # ------------------------------------------------------------------------------------------------------------ img_rows, img_cols = 28, 28 if ke.image_data_format() == 'channels_last': X_train = X_train.reshape(X_train.shape[0], img_rows, img_cols, 1) X_test = X_test.reshape(X_test.shape[0], img_rows, img_cols, 1) input_shape = (img_rows, img_cols, 1) else: X_train = X_train.reshape(X_train.shape[0], 1, img_rows, img_cols) X_test = X_test.reshape(X_test.shape[0], 1, img_rows, img_cols) input_shape = (1, img_rows, img_cols) # 配列の整形と、色の範囲を0~255 → 0~1に変換 X_train = X_train.astype('float32') X_test = X_test.astype('float32') X_train /= 255 X_test /= 255 # ------------------------------------------------------------------------------------------------------------ # ラベルデータ(教師データ、検証データ)のベクトル化 # ------------------------------------------------------------------------------------------------------------ y_train = np_utils.to_categorical(y_train) # 教師ラベルのベクトル化 y_test = np_utils.to_categorical(y_test) # 検証ラベルのベクトル化 # ------------------------------------------------------------------------------------------------------------ # ネットワークの定義 (keras) # ------------------------------------------------------------------------------------------------------------ print("") print("●ネットワーク定義") model = Sequential() # 入力層 28×28×3 model.add(Conv2D(16, kernel_size=(3, 3), activation='relu', input_shape=input_shape, padding='same')) # 01層:畳込み層16枚 model.add(Conv2D(32, (3, 3), activation='relu', padding='same')) # 02層:畳込み層32枚 model.add(MaxPooling2D(pool_size=(2, 2))) # 03層:プーリング層 model.add(Dropout(0.25)) # 04層:ドロップアウト model.add(Conv2D(32, (3, 3), activation='relu', padding='same')) # 05層:畳込み層64枚 model.add(MaxPooling2D(pool_size=(2, 2))) # 06層:プーリング層 model.add(Flatten()) # 08層:次元変換 model.add(Dense(128, activation='relu')) # 09層:全結合出力128 model.add(Dense(10, activation='softmax')) # 10層:全結合出力10 # model表示 model.summary() # コンパイル # 損失関数 :categorical_crossentropy (クロスエントロピー) # 最適化 :Adam model.compile(loss='categorical_crossentropy', optimizer='Adam', metrics=['accuracy']) print("") print("●学習スタート") f_verbose = 1 # 0:表示なし、1:詳細表示、2:表示 hist = model.fit(X_train, y_train, batch_size=batch_size, epochs=epochs, validation_data=(X_test, y_test), verbose=f_verbose) # ------------------------------------------------------------------------------------------------------------ # 損失値グラフ化 # ------------------------------------------------------------------------------------------------------------ # Accuracy (正解率) plt.plot(range(epochs), hist.history['accuracy'], marker='.') plt.plot(range(epochs), hist.history['val_accuracy'], marker='.') plt.title('Accuracy') plt.ylabel('accuracy') plt.xlabel('epoch') plt.legend(['train', 'test'], loc='lower right') plt.show() # loss (損失関数) plt.plot(range(epochs), hist.history['loss'], marker='.') plt.plot(range(epochs), hist.history['val_loss'], marker='.') plt.title('loss Function') plt.ylabel('loss') plt.xlabel('epoch') plt.legend(['train', 'test'], loc='upper right') plt.show() # ------------------------------------------------------------------------------------------------------------ # テストデータ検証 # ------------------------------------------------------------------------------------------------------------ print("") print("●検証結果") t_verbose = 1 # 0:表示なし、1:詳細表示、2:表示 score = model.evaluate(X_test, y_test, verbose=t_verbose) print("") print("batch_size = ", batch_size) print("epochs = ", epochs) print('Test loss:', score[0]) print('Test accuracy:', score[1]) print("") print("●混同行列(コンフュージョンマトリックス) 横:識別結果、縦:正解データ") predict_classes = model.predict_classes(X_test[1:60000, ], batch_size=batch_size) true_classes = np.argmax(y_test[1:60000], 1) print(confusion_matrix(true_classes, predict_classes)) # ------------------------------------------------------------------------------------------------------------ # 正誤表表示 # ------------------------------------------------------------------------------------------------------------ show_prediction() plt.show()

足りないライブラリを以下にまとめます

ライブラリはパッケージに入っています。

sklearnライブラリだけ、scikit-learnというパッケージに入っているので注意。

No. 足りないライブラリ名 必要なパッケージ名称 1 keras keras 2 numpy numpy 3 matplotlib matplotlib 4 sklearn scikit-learn パッケージのインストール

●ライブラリを追加したいので、それに適合したパッケージを追加します

- anacondaを起動し、[

Envionments] -> [python37]をクリック

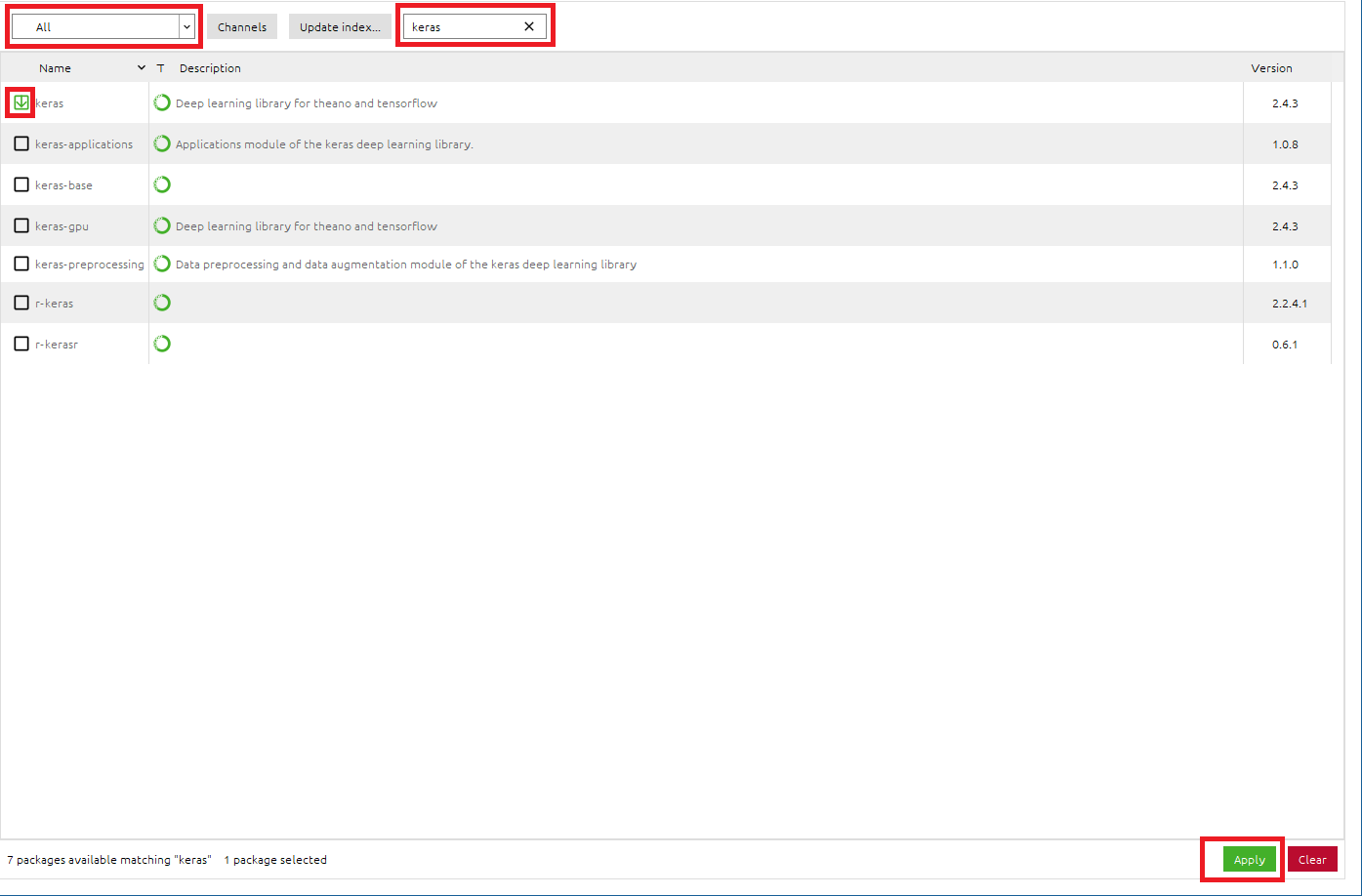

●kerasパッケージをインストールします

●numpyパッケージをインストールします

- 検索BOXに[

numpy]と入力し、numpyパッケージを検索- numpyパッケージがInstallされていることを確認できました。

kerasはnumpyを使用するため、依存関係からkerasパッケージのインストール時に、numpyも自動的にインストールされていました。ということで、numpyのインストール作業は割愛できました。

●matplotlibパッケージをインストールします

- 検索BOXに[

matplotlib]と入力し、matplotlibパッケージを検索- [

matplotlib]のチェックボックスをONに設定- 右下の[

Apply]をクリックして適応させる- Install PackagesのメッセージBOXが出たら、[

Apply]をクリックして、matplotlibパッケージをインストール

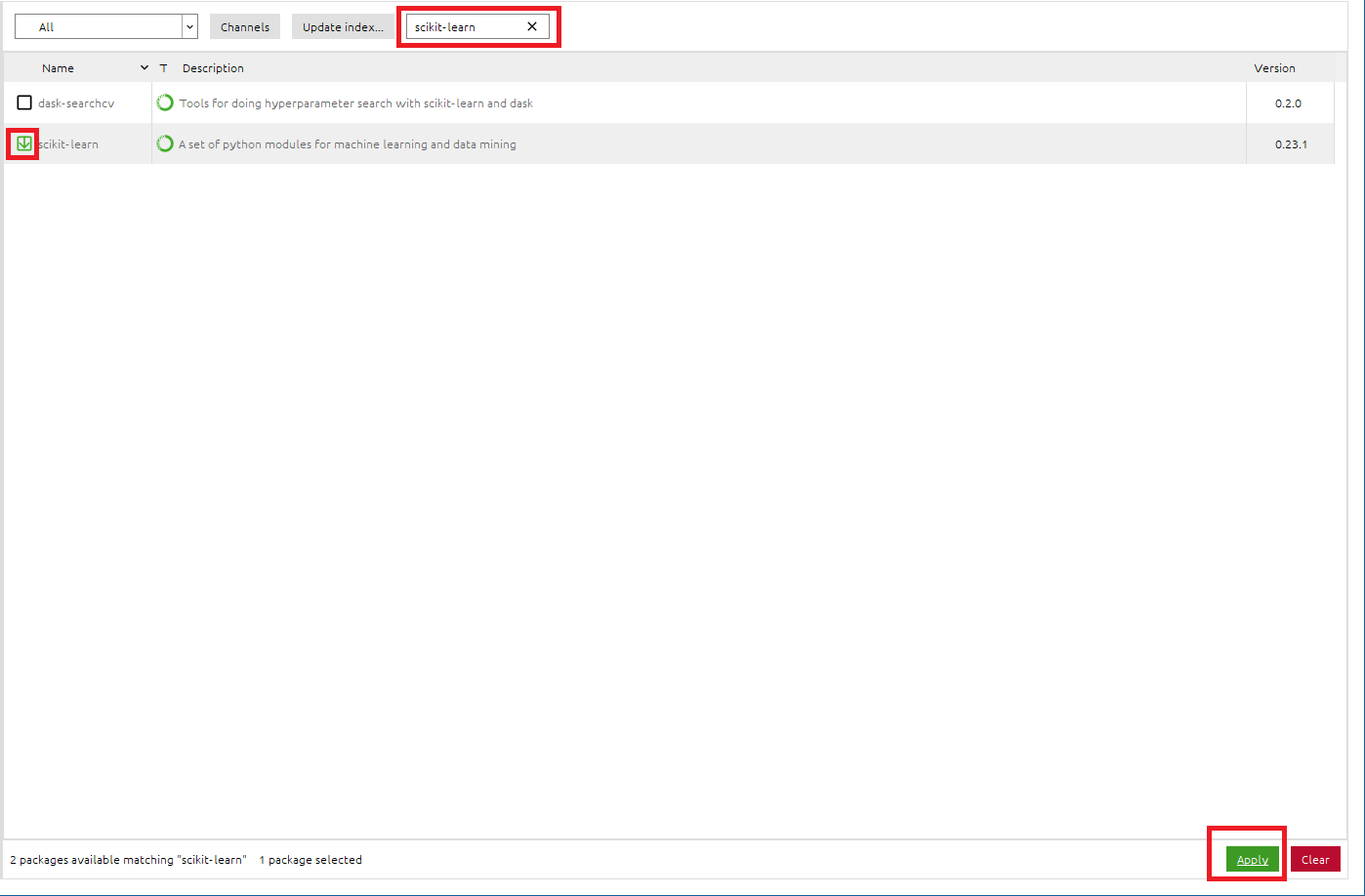

●scikit-learnパッケージをインストールします

- 検索BOXに[

scikit-learn]と入力し、scikit-learnパッケージを検索- [

scikit-learn]のチェックボックスをONに設定- 右下の[

Apply]をクリックして適応させる- Install PackagesのメッセージBOXが出たら、[

Apply]をクリックして、scikit-learnパッケージをインストール※sklearnライブラリは、scikit-learnパッケージに入っています。

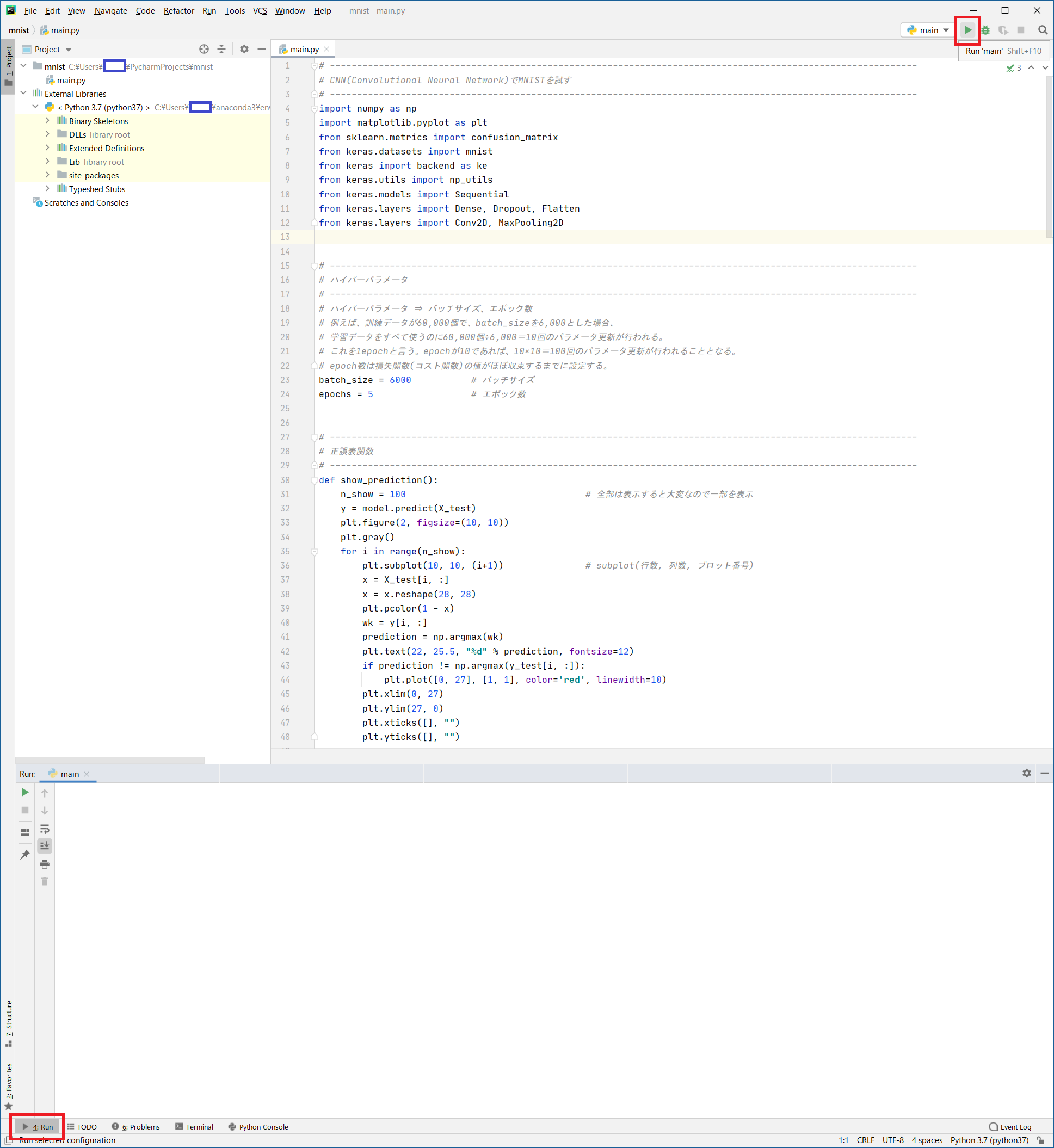

プログラム実行

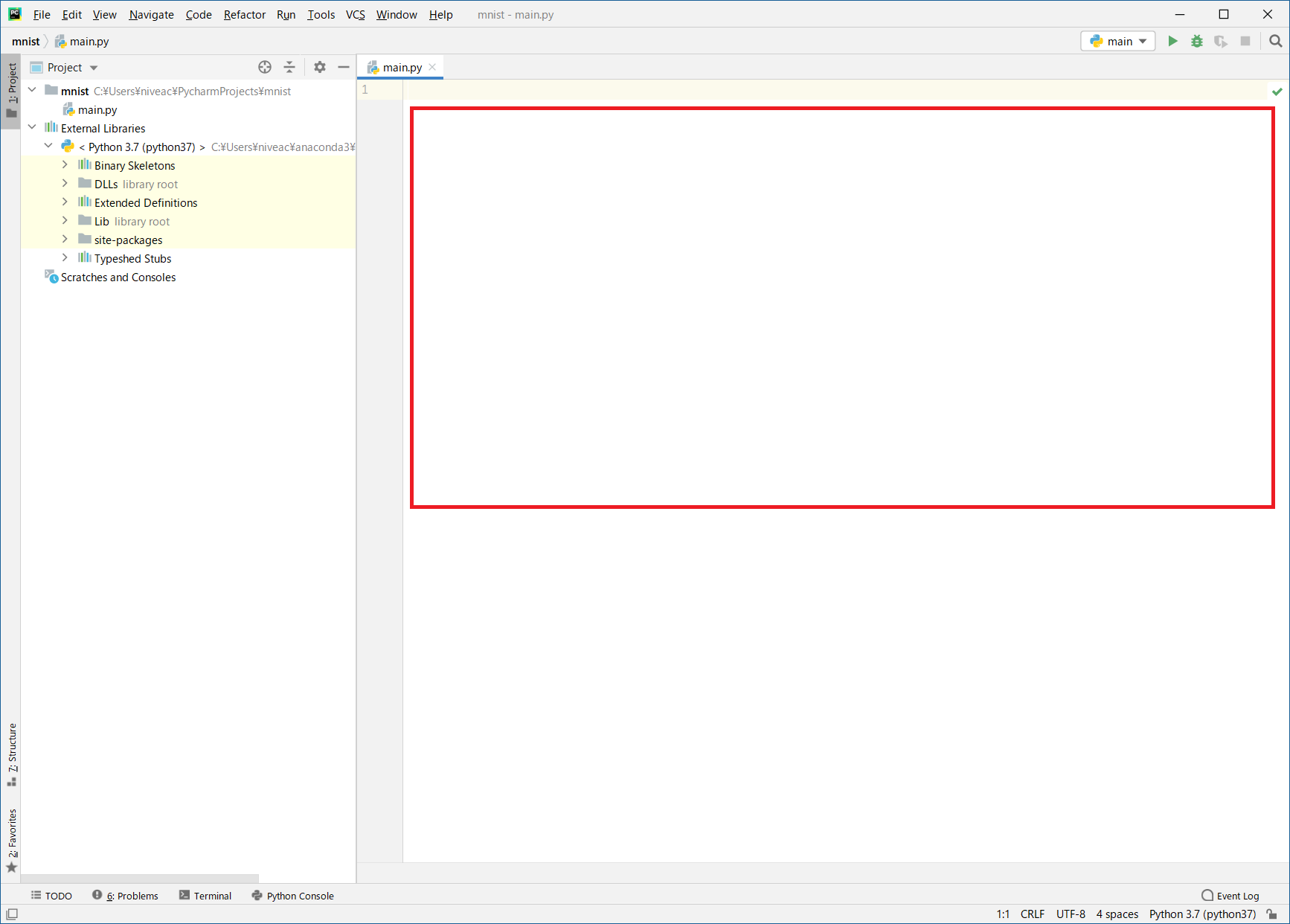

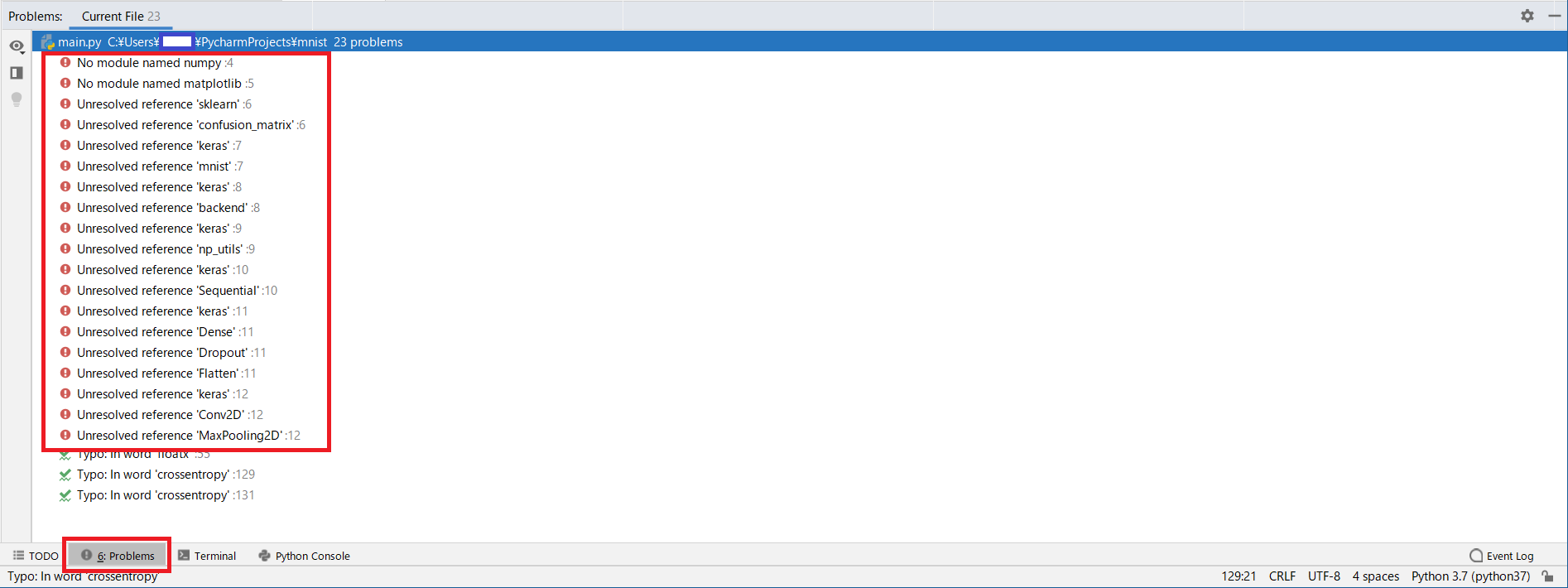

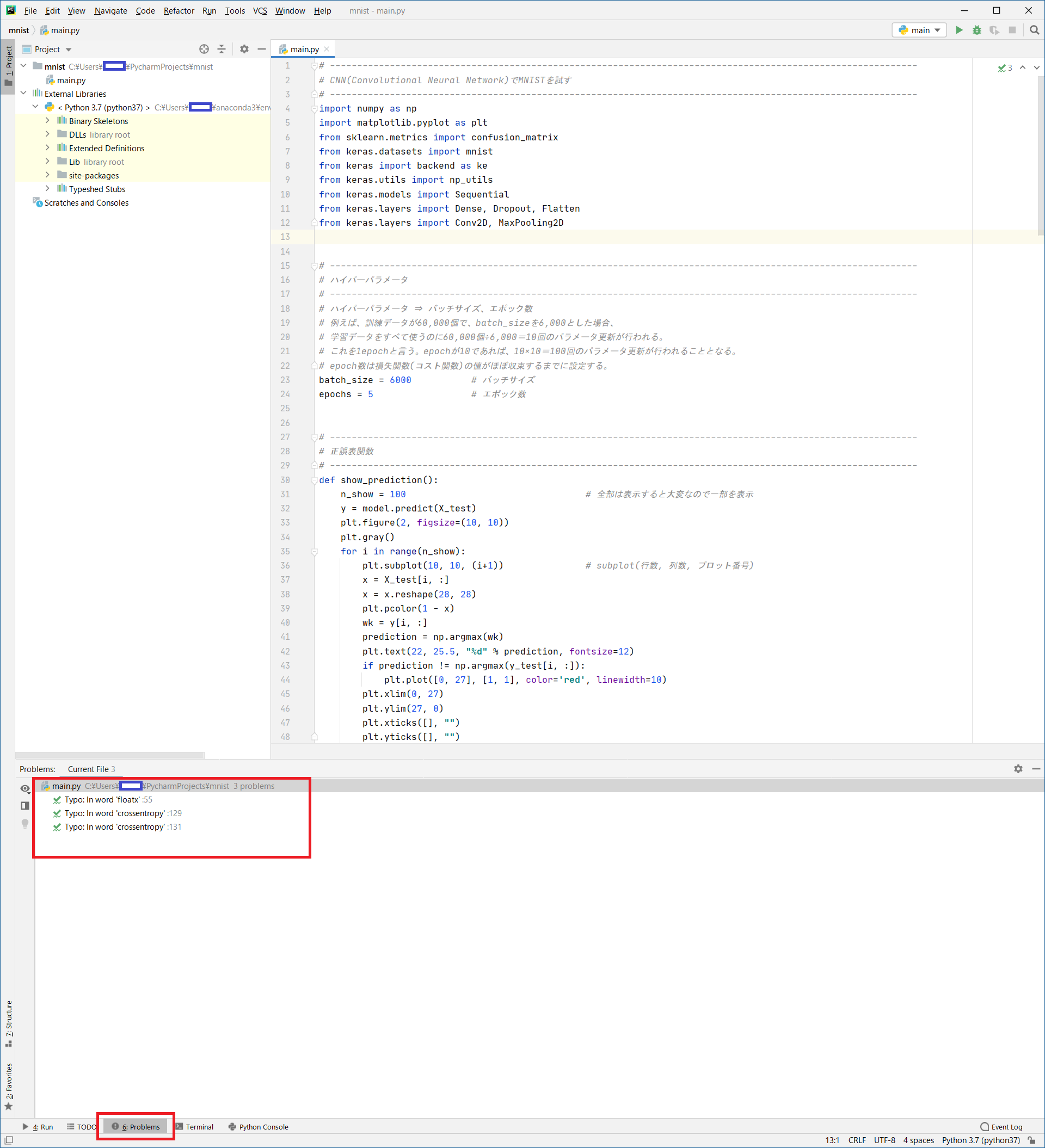

- エラーが全てなくなっていることを確認します。

- [

Problems]をクリック- Problemsに

!赤丸が出ていないことを確認出力結果

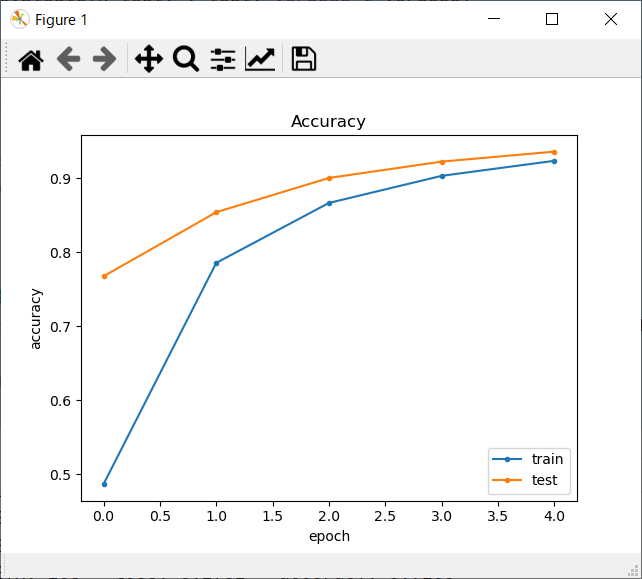

- きちんとできると、以下のような結果が得られます。

- 今回は「Test accuracy: 0.9359999895095825」と結果が得られたので、認識率は93.4%でした。

C:\Users\xxxx\anaconda3\envs\python37\python.exe C:/Users/xxxx/PycharmProjects/mnist_sample/qiita.py Using TensorFlow backend. ●ネットワーク定義 2020-08-06 11:36:11.346263: I tensorflow/core/platform/cpu_feature_guard.cc:142] Your CPU supports instructions that this TensorFlow binary was not compiled to use: AVX AVX2 Model: "sequential_1" _________________________________________________________________ Layer (type) Output Shape Param # ================================================================= conv2d_1 (Conv2D) (None, 28, 28, 16) 160 _________________________________________________________________ conv2d_2 (Conv2D) (None, 28, 28, 32) 4640 _________________________________________________________________ max_pooling2d_1 (MaxPooling2 (None, 14, 14, 32) 0 _________________________________________________________________ dropout_1 (Dropout) (None, 14, 14, 32) 0 _________________________________________________________________ conv2d_3 (Conv2D) (None, 14, 14, 32) 9248 _________________________________________________________________ max_pooling2d_2 (MaxPooling2 (None, 7, 7, 32) 0 _________________________________________________________________ flatten_1 (Flatten) (None, 1568) 0 _________________________________________________________________ dense_1 (Dense) (None, 128) 200832 _________________________________________________________________ dense_2 (Dense) (None, 10) 1290 ================================================================= Total params: 216,170 Trainable params: 216,170 Non-trainable params: 0 _________________________________________________________________ ●学習スタート Train on 60000 samples, validate on 10000 samples Epoch 1/5 2020-08-06 11:36:12.480915: W tensorflow/core/framework/cpu_allocator_impl.cc:81] Allocation of 602112000 exceeds 10% of system memory. 2020-08-06 11:36:14.075159: W tensorflow/core/framework/cpu_allocator_impl.cc:81] Allocation of 602112000 exceeds 10% of system memory. 6000/60000 [==>...........................] - ETA: 36s - loss: 2.3063 - accuracy: 0.0653 12000/60000 [=====>........................] - ETA: 32s - loss: 2.2858 - accuracy: 0.1563 18000/60000 [========>.....................] - ETA: 29s - loss: 2.2630 - accuracy: 0.2346 24000/60000 [===========>..................] - ETA: 24s - loss: 2.2374 - accuracy: 0.2971 30000/60000 [==============>...............] - ETA: 20s - loss: 2.2083 - accuracy: 0.3415 36000/60000 [=================>............] - ETA: 16s - loss: 2.1742 - accuracy: 0.3779 42000/60000 [====================>.........] - ETA: 12s - loss: 2.1342 - accuracy: 0.4095 48000/60000 [=======================>......] - ETA: 8s - loss: 2.0883 - accuracy: 0.4363 54000/60000 [==========================>...] - ETA: 4s - loss: 2.0373 - accuracy: 0.4610 60000/60000 [==============================] - 44s 733us/step - loss: 1.9787 - accuracy: 0.4864 - val_loss: 1.3384 - val_accuracy: 0.7674 Epoch 2/5 6000/60000 [==>...........................] - ETA: 39s - loss: 1.3002 - accuracy: 0.7305 12000/60000 [=====>........................] - ETA: 37s - loss: 1.2238 - accuracy: 0.7381 18000/60000 [========>.....................] - ETA: 33s - loss: 1.1505 - accuracy: 0.7432 24000/60000 [===========>..................] - ETA: 27s - loss: 1.0788 - accuracy: 0.7513 30000/60000 [==============>...............] - ETA: 23s - loss: 1.0145 - accuracy: 0.7597 36000/60000 [=================>............] - ETA: 18s - loss: 0.9617 - accuracy: 0.7652 42000/60000 [====================>.........] - ETA: 14s - loss: 0.9165 - accuracy: 0.7698 48000/60000 [=======================>......] - ETA: 9s - loss: 0.8742 - accuracy: 0.7754 54000/60000 [==========================>...] - ETA: 4s - loss: 0.8390 - accuracy: 0.7804 60000/60000 [==============================] - 50s 831us/step - loss: 0.8084 - accuracy: 0.7856 - val_loss: 0.4861 - val_accuracy: 0.8541 Epoch 3/5 6000/60000 [==>...........................] - ETA: 41s - loss: 0.4924 - accuracy: 0.8445 12000/60000 [=====>........................] - ETA: 36s - loss: 0.4970 - accuracy: 0.8453 18000/60000 [========>.....................] - ETA: 32s - loss: 0.5020 - accuracy: 0.8486 24000/60000 [===========>..................] - ETA: 28s - loss: 0.5005 - accuracy: 0.8508 30000/60000 [==============>...............] - ETA: 23s - loss: 0.4866 - accuracy: 0.8547 36000/60000 [=================>............] - ETA: 19s - loss: 0.4774 - accuracy: 0.8578 42000/60000 [====================>.........] - ETA: 14s - loss: 0.4730 - accuracy: 0.8603 48000/60000 [=======================>......] - ETA: 9s - loss: 0.4721 - accuracy: 0.8622 54000/60000 [==========================>...] - ETA: 4s - loss: 0.4641 - accuracy: 0.8648 60000/60000 [==============================] - 52s 862us/step - loss: 0.4574 - accuracy: 0.8666 - val_loss: 0.3624 - val_accuracy: 0.9004 Epoch 4/5 6000/60000 [==>...........................] - ETA: 44s - loss: 0.3941 - accuracy: 0.8850 12000/60000 [=====>........................] - ETA: 40s - loss: 0.3863 - accuracy: 0.8882 18000/60000 [========>.....................] - ETA: 34s - loss: 0.3731 - accuracy: 0.8912 24000/60000 [===========>..................] - ETA: 29s - loss: 0.3659 - accuracy: 0.8943 30000/60000 [==============>...............] - ETA: 25s - loss: 0.3545 - accuracy: 0.8971 36000/60000 [=================>............] - ETA: 20s - loss: 0.3461 - accuracy: 0.8987 42000/60000 [====================>.........] - ETA: 15s - loss: 0.3417 - accuracy: 0.9001 48000/60000 [=======================>......] - ETA: 10s - loss: 0.3421 - accuracy: 0.9008 54000/60000 [==========================>...] - ETA: 5s - loss: 0.3367 - accuracy: 0.9023 60000/60000 [==============================] - 52s 874us/step - loss: 0.3332 - accuracy: 0.9033 - val_loss: 0.2740 - val_accuracy: 0.9225 Epoch 5/5 6000/60000 [==>...........................] - ETA: 44s - loss: 0.2830 - accuracy: 0.9168 12000/60000 [=====>........................] - ETA: 39s - loss: 0.2939 - accuracy: 0.9151 18000/60000 [========>.....................] - ETA: 35s - loss: 0.2872 - accuracy: 0.9168 24000/60000 [===========>..................] - ETA: 30s - loss: 0.2782 - accuracy: 0.9193 30000/60000 [==============>...............] - ETA: 25s - loss: 0.2782 - accuracy: 0.9188 36000/60000 [=================>............] - ETA: 20s - loss: 0.2733 - accuracy: 0.9200 42000/60000 [====================>.........] - ETA: 15s - loss: 0.2686 - accuracy: 0.9217 48000/60000 [=======================>......] - ETA: 10s - loss: 0.2684 - accuracy: 0.9222 54000/60000 [==========================>...] - ETA: 4s - loss: 0.2654 - accuracy: 0.9233 60000/60000 [==============================] - 52s 872us/step - loss: 0.2634 - accuracy: 0.9236 - val_loss: 0.2180 - val_accuracy: 0.9360 ●検証結果 32/10000 [..............................] - ETA: 5s 320/10000 [..............................] - ETA: 2s 608/10000 [>.............................] - ETA: 2s 928/10000 [=>............................] - ETA: 1s 1248/10000 [==>...........................] - ETA: 1s 1568/10000 [===>..........................] - ETA: 1s 1920/10000 [====>.........................] - ETA: 1s 2272/10000 [=====>........................] - ETA: 1s 2624/10000 [======>.......................] - ETA: 1s 2976/10000 [=======>......................] - ETA: 1s 3328/10000 [========>.....................] - ETA: 1s 3680/10000 [==========>...................] - ETA: 1s 4032/10000 [===========>..................] - ETA: 1s 4384/10000 [============>.................] - ETA: 1s 4736/10000 [=============>................] - ETA: 0s 5088/10000 [==============>...............] - ETA: 0s 5408/10000 [===============>..............] - ETA: 0s 5728/10000 [================>.............] - ETA: 0s 6048/10000 [=================>............] - ETA: 0s 6368/10000 [==================>...........] - ETA: 0s 6560/10000 [==================>...........] - ETA: 0s 6816/10000 [===================>..........] - ETA: 0s 7104/10000 [====================>.........] - ETA: 0s 7392/10000 [=====================>........] - ETA: 0s 7680/10000 [======================>.......] - ETA: 0s 8000/10000 [=======================>......] - ETA: 0s 8320/10000 [=======================>......] - ETA: 0s 8640/10000 [========================>.....] - ETA: 0s 8960/10000 [=========================>....] - ETA: 0s 9280/10000 [==========================>...] - ETA: 0s 9600/10000 [===========================>..] - ETA: 0s 9920/10000 [============================>.] - ETA: 0s 10000/10000 [==============================] - 2s 196us/step batch_size = 6000 epochs = 5 Test loss: 0.21799209741055967 Test accuracy: 0.9359999895095825 ●混同行列(コンフュージョンマトリックス) 横:識別結果、縦:正解データ [[ 966 0 1 1 0 1 6 1 4 0] [ 0 1108 4 2 0 0 3 1 17 0] [ 12 2 954 18 7 0 7 8 21 3] [ 2 2 7 938 0 24 0 11 19 7] [ 1 2 4 1 908 0 10 3 5 48] [ 5 1 3 18 0 834 9 2 14 6] [ 18 4 2 2 6 14 906 2 4 0] [ 1 5 26 7 7 1 0 916 4 60] [ 10 0 5 23 9 18 8 4 878 19] [ 10 5 3 13 8 6 0 7 6 951]] Process finished with exit code 0正解率

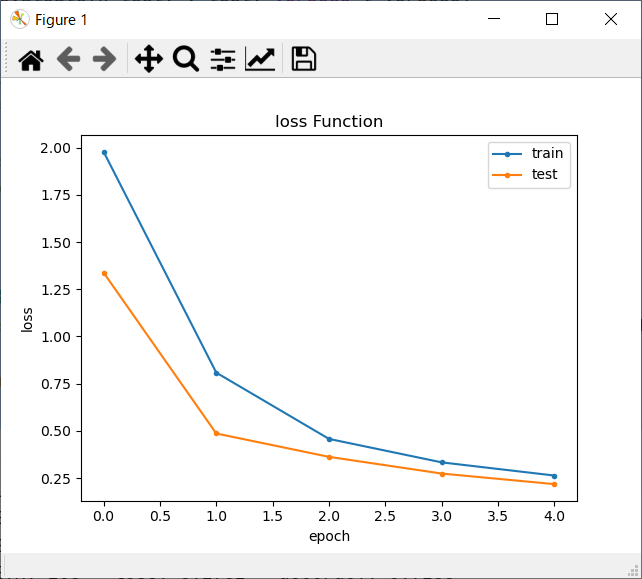

損失関数結果

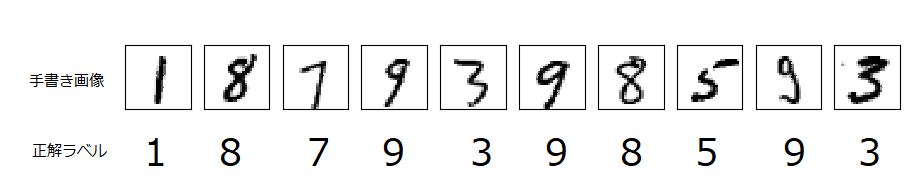

正誤表

- 検証データは10,000枚ありますが、全部出力させると大変なので、最初の100枚まで結果を出力させています。

- 赤色線で示したものが、AIが認識誤りを起こしたものです。

- 枠内右下にAIが認識した数字を記載しています。

以上

- お疲れ様でした!

- 投稿日:2020-08-06T21:47:47+09:00

3.PythonによるAIプログラミング

はじめに

いきなりこのページに来られた方は、

親ページから参照をお願いいたします。ここの目的

pycharmを使用して、python言語でAIをコーディングします。コードはコピペでOKです。

ソースコード内の意味が分からなくても実行できます。開発環境の立ち上げ

Pythonプログラムを作成するためにpycharm(PyCharm Community Edition)を起動します。前回作ったPJが表示されるので「

mnist」をクリック

このサンプルのソースコードは、AIとは全く関係がないものなので全部消去します (サンプルのソースコードは、

CTL+AしてDELキーで簡単に消せます)

PythonによるAIプログラミング

- ソースコードは以下です。

main.py# ------------------------------------------------------------------------------------------------------------ # CNN(Convolutional Neural Network)でMNISTを試す # ------------------------------------------------------------------------------------------------------------ import numpy as np import matplotlib.pyplot as plt from sklearn.metrics import confusion_matrix from keras.datasets import mnist from keras import backend as ke from keras.utils import np_utils from keras.models import Sequential from keras.layers import Dense, Dropout, Flatten from keras.layers import Conv2D, MaxPooling2D # ------------------------------------------------------------------------------------------------------------ # ハイパーパラメータ # ------------------------------------------------------------------------------------------------------------ # ハイパーパラメータ ⇒ バッチサイズ、エポック数 # 例えば、訓練データが60,000個で、batch_sizeを6,000とした場合、 # 学習データをすべて使うのに60,000個÷6,000=10回のパラメータ更新が行われる。 # これを1epochと言う。epochが10であれば、10×10=100回のパラメータ更新が行われることとなる。 # epoch数は損失関数(コスト関数)の値がほぼ収束するまでに設定する。 batch_size = 6000 # バッチサイズ epochs = 5 # エポック数 # ------------------------------------------------------------------------------------------------------------ # 正誤表関数 # ------------------------------------------------------------------------------------------------------------ def show_prediction(): n_show = 100 # 全部は表示すると大変なので一部を表示 y = model.predict(X_test) plt.figure(2, figsize=(10, 10)) plt.gray() for i in range(n_show): plt.subplot(10, 10, (i+1)) # subplot(行数, 列数, プロット番号) x = X_test[i, :] x = x.reshape(28, 28) plt.pcolor(1 - x) wk = y[i, :] prediction = np.argmax(wk) plt.text(22, 25.5, "%d" % prediction, fontsize=12) if prediction != np.argmax(y_test[i, :]): plt.plot([0, 27], [1, 1], color='red', linewidth=10) plt.xlim(0, 27) plt.ylim(27, 0) plt.xticks([], "") plt.yticks([], "") # ------------------------------------------------------------------------------------------------------------ # keras backendの表示 # ------------------------------------------------------------------------------------------------------------ # print(ke.backend()) # print(ke.floatx()) # ------------------------------------------------------------------------------------------------------------ # MNISTデータの取得 # ------------------------------------------------------------------------------------------------------------ # 初回はダウンロードが発生するため時間がかかる # 60,000枚の28x28ドットで表現される10個の数字の白黒画像と10,000枚のテスト用画像データセット # ダウンロード場所:'~/.keras/datasets/' # ※MNISTのデータダウンロードがNGとなる場合は、PROXYの設定を見直してください # # MNISTデータ # ├ 教師データ (60,000個) # │ ├ 画像データ # │ └ ラベルデータ # │ # └ 検証データ (10,000個) # ├ 画像データ # └ ラベルデータ # ↓教師データ ↓検証データ (X_train, y_train), (X_test, y_test) = mnist.load_data() # ↑画像 ↑ラベル ↑画像 ↑ラベル # ------------------------------------------------------------------------------------------------------------ # 画像データ(教師データ、検証データ)のリシェイプ # ------------------------------------------------------------------------------------------------------------ img_rows, img_cols = 28, 28 if ke.image_data_format() == 'channels_last': X_train = X_train.reshape(X_train.shape[0], img_rows, img_cols, 1) X_test = X_test.reshape(X_test.shape[0], img_rows, img_cols, 1) input_shape = (img_rows, img_cols, 1) else: X_train = X_train.reshape(X_train.shape[0], 1, img_rows, img_cols) X_test = X_test.reshape(X_test.shape[0], 1, img_rows, img_cols) input_shape = (1, img_rows, img_cols) # 配列の整形と、色の範囲を0~255 → 0~1に変換 X_train = X_train.astype('float32') X_test = X_test.astype('float32') X_train /= 255 X_test /= 255 # ------------------------------------------------------------------------------------------------------------ # ラベルデータ(教師データ、検証データ)のベクトル化 # ------------------------------------------------------------------------------------------------------------ y_train = np_utils.to_categorical(y_train) # 教師ラベルのベクトル化 y_test = np_utils.to_categorical(y_test) # 検証ラベルのベクトル化 # ------------------------------------------------------------------------------------------------------------ # ネットワークの定義 (keras) # ------------------------------------------------------------------------------------------------------------ print("") print("●ネットワーク定義") model = Sequential() # 入力層 28×28×3 model.add(Conv2D(16, kernel_size=(3, 3), activation='relu', input_shape=input_shape, padding='same')) # 01層:畳込み層16枚 model.add(Conv2D(32, (3, 3), activation='relu', padding='same')) # 02層:畳込み層32枚 model.add(MaxPooling2D(pool_size=(2, 2))) # 03層:プーリング層 model.add(Dropout(0.25)) # 04層:ドロップアウト model.add(Conv2D(32, (3, 3), activation='relu', padding='same')) # 05層:畳込み層64枚 model.add(MaxPooling2D(pool_size=(2, 2))) # 06層:プーリング層 model.add(Flatten()) # 08層:次元変換 model.add(Dense(128, activation='relu')) # 09層:全結合出力128 model.add(Dense(10, activation='softmax')) # 10層:全結合出力10 # model表示 model.summary() # コンパイル # 損失関数 :categorical_crossentropy (クロスエントロピー) # 最適化 :Adam model.compile(loss='categorical_crossentropy', optimizer='Adam', metrics=['accuracy']) print("") print("●学習スタート") f_verbose = 1 # 0:表示なし、1:詳細表示、2:表示 hist = model.fit(X_train, y_train, batch_size=batch_size, epochs=epochs, validation_data=(X_test, y_test), verbose=f_verbose) # ------------------------------------------------------------------------------------------------------------ # 損失値グラフ化 # ------------------------------------------------------------------------------------------------------------ # Accuracy (正解率) plt.plot(range(epochs), hist.history['accuracy'], marker='.') plt.plot(range(epochs), hist.history['val_accuracy'], marker='.') plt.title('Accuracy') plt.ylabel('accuracy') plt.xlabel('epoch') plt.legend(['train', 'test'], loc='lower right') plt.show() # loss (損失関数) plt.plot(range(epochs), hist.history['loss'], marker='.') plt.plot(range(epochs), hist.history['val_loss'], marker='.') plt.title('loss Function') plt.ylabel('loss') plt.xlabel('epoch') plt.legend(['train', 'test'], loc='upper right') plt.show() # ------------------------------------------------------------------------------------------------------------ # テストデータ検証 # ------------------------------------------------------------------------------------------------------------ print("") print("●検証結果") t_verbose = 1 # 0:表示なし、1:詳細表示、2:表示 score = model.evaluate(X_test, y_test, verbose=t_verbose) print("") print("batch_size = ", batch_size) print("epochs = ", epochs) print('Test loss:', score[0]) print('Test accuracy:', score[1]) print("") print("●混同行列(コンフュージョンマトリックス) 横:識別結果、縦:正解データ") predict_classes = model.predict_classes(X_test[1:60000, ], batch_size=batch_size) true_classes = np.argmax(y_test[1:60000], 1) print(confusion_matrix(true_classes, predict_classes)) # ------------------------------------------------------------------------------------------------------------ # 正誤表表示 # ------------------------------------------------------------------------------------------------------------ show_prediction() plt.show()

足りないライブラリを以下にまとめます

ライブラリはパッケージに入っています。

sklearnライブラリだけ、scikit-learnというパッケージに入っているので注意。

No. 足りないライブラリ名 必要なパッケージ名称 1 keras keras 2 numpy numpy 3 matplotlib matplotlib 4 sklearn scikit-learn パッケージのインストール

●ライブラリを追加したいので、それに適合したパッケージを追加します

- anacondaを起動し、[

Envionments] -> [python37]をクリック

●kerasパッケージをインストールします

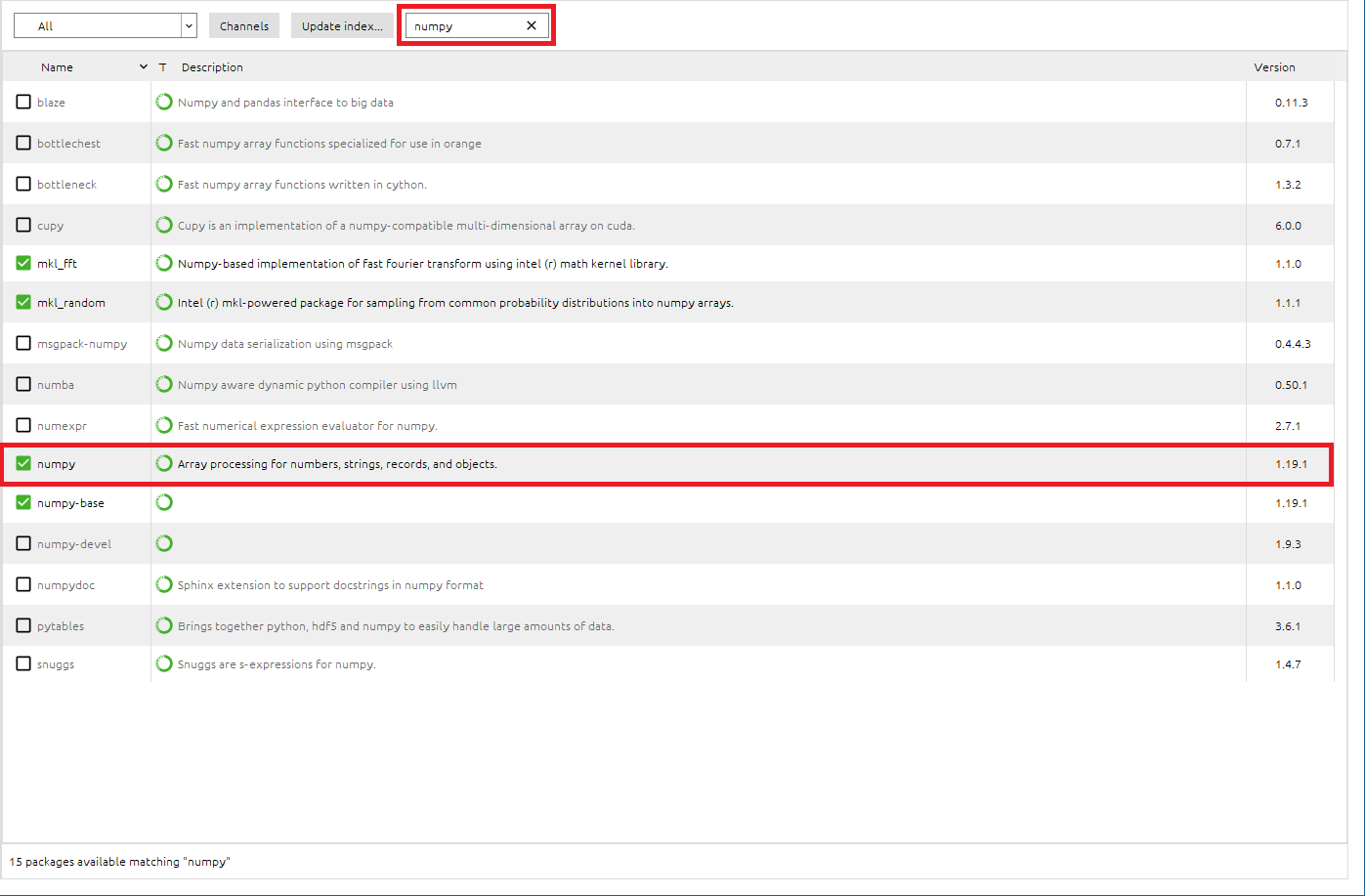

●numpyパッケージをインストールします

- 検索BOXに[

numpy]と入力し、numpyパッケージを検索- numpyパッケージがInstallされていることを確認できました。

kerasはnumpyを使用するため、依存関係からkerasパッケージのインストール時に、numpyも自動的にインストールされていました。ということで、numpyのインストール作業は割愛できました。

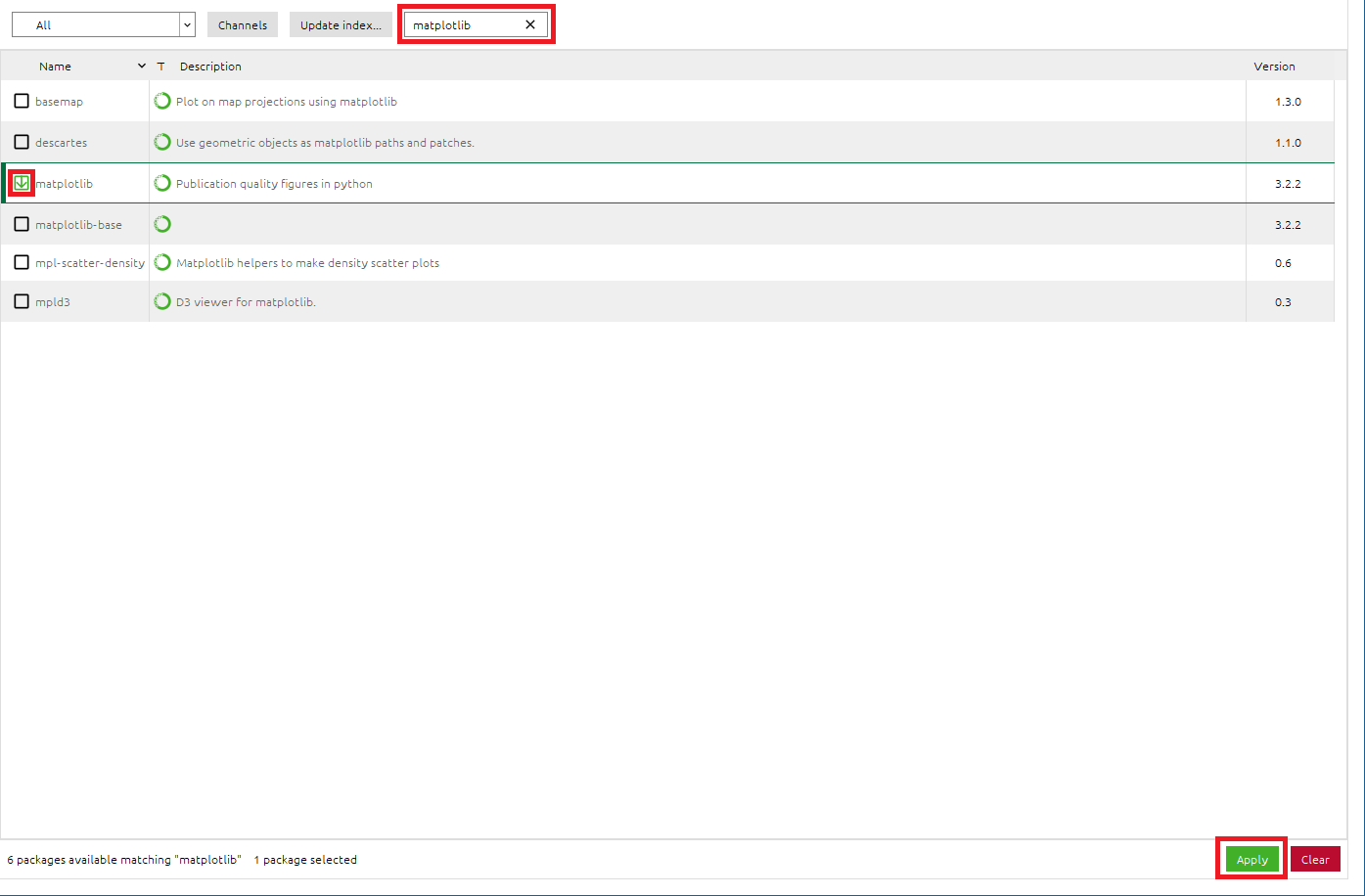

●matplotlibパッケージをインストールします

- 検索BOXに[

matplotlib]と入力し、matplotlibパッケージを検索- [

matplotlib]のチェックボックスをONに設定- 右下の[

Apply]をクリックして適応させる- Install PackagesのメッセージBOXが出たら、[

Apply]をクリックして、matplotlibパッケージをインストール

●scikit-learnパッケージをインストールします

- 検索BOXに[

scikit-learn]と入力し、scikit-learnパッケージを検索- [

scikit-learn]のチェックボックスをONに設定- 右下の[

Apply]をクリックして適応させる- Install PackagesのメッセージBOXが出たら、[

Apply]をクリックして、scikit-learnパッケージをインストール※sklearnライブラリは、scikit-learnパッケージに入っています。

プログラム実行

- エラーが全てなくなっていることを確認します。

- [

Problems]をクリック- Problemsに

!赤丸が出ていないことを確認出力結果

- きちんとできると、以下のような結果が得られます。

- 今回は「Test accuracy: 0.9359999895095825」と結果が得られたので、認識率は93.4%でした。

C:\Users\xxxx\anaconda3\envs\python37\python.exe C:/Users/xxxx/PycharmProjects/mnist_sample/qiita.py Using TensorFlow backend. ●ネットワーク定義 2020-08-06 11:36:11.346263: I tensorflow/core/platform/cpu_feature_guard.cc:142] Your CPU supports instructions that this TensorFlow binary was not compiled to use: AVX AVX2 Model: "sequential_1" _________________________________________________________________ Layer (type) Output Shape Param # ================================================================= conv2d_1 (Conv2D) (None, 28, 28, 16) 160 _________________________________________________________________ conv2d_2 (Conv2D) (None, 28, 28, 32) 4640 _________________________________________________________________ max_pooling2d_1 (MaxPooling2 (None, 14, 14, 32) 0 _________________________________________________________________ dropout_1 (Dropout) (None, 14, 14, 32) 0 _________________________________________________________________ conv2d_3 (Conv2D) (None, 14, 14, 32) 9248 _________________________________________________________________ max_pooling2d_2 (MaxPooling2 (None, 7, 7, 32) 0 _________________________________________________________________ flatten_1 (Flatten) (None, 1568) 0 _________________________________________________________________ dense_1 (Dense) (None, 128) 200832 _________________________________________________________________ dense_2 (Dense) (None, 10) 1290 ================================================================= Total params: 216,170 Trainable params: 216,170 Non-trainable params: 0 _________________________________________________________________ ●学習スタート Train on 60000 samples, validate on 10000 samples Epoch 1/5 2020-08-06 11:36:12.480915: W tensorflow/core/framework/cpu_allocator_impl.cc:81] Allocation of 602112000 exceeds 10% of system memory. 2020-08-06 11:36:14.075159: W tensorflow/core/framework/cpu_allocator_impl.cc:81] Allocation of 602112000 exceeds 10% of system memory. 6000/60000 [==>...........................] - ETA: 36s - loss: 2.3063 - accuracy: 0.0653 12000/60000 [=====>........................] - ETA: 32s - loss: 2.2858 - accuracy: 0.1563 18000/60000 [========>.....................] - ETA: 29s - loss: 2.2630 - accuracy: 0.2346 24000/60000 [===========>..................] - ETA: 24s - loss: 2.2374 - accuracy: 0.2971 30000/60000 [==============>...............] - ETA: 20s - loss: 2.2083 - accuracy: 0.3415 36000/60000 [=================>............] - ETA: 16s - loss: 2.1742 - accuracy: 0.3779 42000/60000 [====================>.........] - ETA: 12s - loss: 2.1342 - accuracy: 0.4095 48000/60000 [=======================>......] - ETA: 8s - loss: 2.0883 - accuracy: 0.4363 54000/60000 [==========================>...] - ETA: 4s - loss: 2.0373 - accuracy: 0.4610 60000/60000 [==============================] - 44s 733us/step - loss: 1.9787 - accuracy: 0.4864 - val_loss: 1.3384 - val_accuracy: 0.7674 Epoch 2/5 6000/60000 [==>...........................] - ETA: 39s - loss: 1.3002 - accuracy: 0.7305 12000/60000 [=====>........................] - ETA: 37s - loss: 1.2238 - accuracy: 0.7381 18000/60000 [========>.....................] - ETA: 33s - loss: 1.1505 - accuracy: 0.7432 24000/60000 [===========>..................] - ETA: 27s - loss: 1.0788 - accuracy: 0.7513 30000/60000 [==============>...............] - ETA: 23s - loss: 1.0145 - accuracy: 0.7597 36000/60000 [=================>............] - ETA: 18s - loss: 0.9617 - accuracy: 0.7652 42000/60000 [====================>.........] - ETA: 14s - loss: 0.9165 - accuracy: 0.7698 48000/60000 [=======================>......] - ETA: 9s - loss: 0.8742 - accuracy: 0.7754 54000/60000 [==========================>...] - ETA: 4s - loss: 0.8390 - accuracy: 0.7804 60000/60000 [==============================] - 50s 831us/step - loss: 0.8084 - accuracy: 0.7856 - val_loss: 0.4861 - val_accuracy: 0.8541 Epoch 3/5 6000/60000 [==>...........................] - ETA: 41s - loss: 0.4924 - accuracy: 0.8445 12000/60000 [=====>........................] - ETA: 36s - loss: 0.4970 - accuracy: 0.8453 18000/60000 [========>.....................] - ETA: 32s - loss: 0.5020 - accuracy: 0.8486 24000/60000 [===========>..................] - ETA: 28s - loss: 0.5005 - accuracy: 0.8508 30000/60000 [==============>...............] - ETA: 23s - loss: 0.4866 - accuracy: 0.8547 36000/60000 [=================>............] - ETA: 19s - loss: 0.4774 - accuracy: 0.8578 42000/60000 [====================>.........] - ETA: 14s - loss: 0.4730 - accuracy: 0.8603 48000/60000 [=======================>......] - ETA: 9s - loss: 0.4721 - accuracy: 0.8622 54000/60000 [==========================>...] - ETA: 4s - loss: 0.4641 - accuracy: 0.8648 60000/60000 [==============================] - 52s 862us/step - loss: 0.4574 - accuracy: 0.8666 - val_loss: 0.3624 - val_accuracy: 0.9004 Epoch 4/5 6000/60000 [==>...........................] - ETA: 44s - loss: 0.3941 - accuracy: 0.8850 12000/60000 [=====>........................] - ETA: 40s - loss: 0.3863 - accuracy: 0.8882 18000/60000 [========>.....................] - ETA: 34s - loss: 0.3731 - accuracy: 0.8912 24000/60000 [===========>..................] - ETA: 29s - loss: 0.3659 - accuracy: 0.8943 30000/60000 [==============>...............] - ETA: 25s - loss: 0.3545 - accuracy: 0.8971 36000/60000 [=================>............] - ETA: 20s - loss: 0.3461 - accuracy: 0.8987 42000/60000 [====================>.........] - ETA: 15s - loss: 0.3417 - accuracy: 0.9001 48000/60000 [=======================>......] - ETA: 10s - loss: 0.3421 - accuracy: 0.9008 54000/60000 [==========================>...] - ETA: 5s - loss: 0.3367 - accuracy: 0.9023 60000/60000 [==============================] - 52s 874us/step - loss: 0.3332 - accuracy: 0.9033 - val_loss: 0.2740 - val_accuracy: 0.9225 Epoch 5/5 6000/60000 [==>...........................] - ETA: 44s - loss: 0.2830 - accuracy: 0.9168 12000/60000 [=====>........................] - ETA: 39s - loss: 0.2939 - accuracy: 0.9151 18000/60000 [========>.....................] - ETA: 35s - loss: 0.2872 - accuracy: 0.9168 24000/60000 [===========>..................] - ETA: 30s - loss: 0.2782 - accuracy: 0.9193 30000/60000 [==============>...............] - ETA: 25s - loss: 0.2782 - accuracy: 0.9188 36000/60000 [=================>............] - ETA: 20s - loss: 0.2733 - accuracy: 0.9200 42000/60000 [====================>.........] - ETA: 15s - loss: 0.2686 - accuracy: 0.9217 48000/60000 [=======================>......] - ETA: 10s - loss: 0.2684 - accuracy: 0.9222 54000/60000 [==========================>...] - ETA: 4s - loss: 0.2654 - accuracy: 0.9233 60000/60000 [==============================] - 52s 872us/step - loss: 0.2634 - accuracy: 0.9236 - val_loss: 0.2180 - val_accuracy: 0.9360 ●検証結果 32/10000 [..............................] - ETA: 5s 320/10000 [..............................] - ETA: 2s 608/10000 [>.............................] - ETA: 2s 928/10000 [=>............................] - ETA: 1s 1248/10000 [==>...........................] - ETA: 1s 1568/10000 [===>..........................] - ETA: 1s 1920/10000 [====>.........................] - ETA: 1s 2272/10000 [=====>........................] - ETA: 1s 2624/10000 [======>.......................] - ETA: 1s 2976/10000 [=======>......................] - ETA: 1s 3328/10000 [========>.....................] - ETA: 1s 3680/10000 [==========>...................] - ETA: 1s 4032/10000 [===========>..................] - ETA: 1s 4384/10000 [============>.................] - ETA: 1s 4736/10000 [=============>................] - ETA: 0s 5088/10000 [==============>...............] - ETA: 0s 5408/10000 [===============>..............] - ETA: 0s 5728/10000 [================>.............] - ETA: 0s 6048/10000 [=================>............] - ETA: 0s 6368/10000 [==================>...........] - ETA: 0s 6560/10000 [==================>...........] - ETA: 0s 6816/10000 [===================>..........] - ETA: 0s 7104/10000 [====================>.........] - ETA: 0s 7392/10000 [=====================>........] - ETA: 0s 7680/10000 [======================>.......] - ETA: 0s 8000/10000 [=======================>......] - ETA: 0s 8320/10000 [=======================>......] - ETA: 0s 8640/10000 [========================>.....] - ETA: 0s 8960/10000 [=========================>....] - ETA: 0s 9280/10000 [==========================>...] - ETA: 0s 9600/10000 [===========================>..] - ETA: 0s 9920/10000 [============================>.] - ETA: 0s 10000/10000 [==============================] - 2s 196us/step batch_size = 6000 epochs = 5 Test loss: 0.21799209741055967 Test accuracy: 0.9359999895095825 ●混同行列(コンフュージョンマトリックス) 横:識別結果、縦:正解データ [[ 966 0 1 1 0 1 6 1 4 0] [ 0 1108 4 2 0 0 3 1 17 0] [ 12 2 954 18 7 0 7 8 21 3] [ 2 2 7 938 0 24 0 11 19 7] [ 1 2 4 1 908 0 10 3 5 48] [ 5 1 3 18 0 834 9 2 14 6] [ 18 4 2 2 6 14 906 2 4 0] [ 1 5 26 7 7 1 0 916 4 60] [ 10 0 5 23 9 18 8 4 878 19] [ 10 5 3 13 8 6 0 7 6 951]] Process finished with exit code 0正解率

損失関数結果

正誤表

- 検証データは10,000枚ありますが、全部出力させると大変なので、最初の100枚まで結果を出力させています。

- 赤色線で示したものが、AIが認識誤りを起こしたものです。

- 枠内右下にAIが認識した数字を記載しています。

以上

- お疲れ様でした!

- 投稿日:2020-08-06T21:45:46+09:00

0からはじめる「Python AIプログラミング」 for windows

はじめに

ここでは、windows10を持っていて、AIプログラミングを「手っ取り早く動かしてイメージをつかみたいと思っている方」向けの手順を説明いたします。

初心者向けのもので、目的は開発環境を整えてプログラム (プログラミングはしません。コピペでOKです^^;) を実行し、「ほぉ、AIプログラミングってこんな感じか~」というところがGOALです。

どんなことをやるか

まず

手書きの数字0~9とその正解ラベル(0~9)がセットになった教師データ60,000枚をAIに学習させます。その後、手書きの数字0~9とその正解ラベル(0~9)がセットになった検証データ10,000枚をAIに検証させて、認識率や検証データの手書き数字がAIによって0~9のどの数字と認識したのかを試してみます。

(1) 教師データ(60,000枚)

手書き画像を正解ラベルに沿って、0~9の数字として覚えさせる。

(2) 検証データ(10,000枚)

手書き画像をAIにより0~9の数字に分類(クラス分類)させ、正解データと比較し当たったかどうかを判定。

※上記データは プログラム実行時に MNISTデータベース から自動的にダウンロードされますので、

画像ファイルの収集や正解ラベリング(画像データと正解ラベルの結びつけ)等の前準備は一切不要となっています。開発環境インストール

まず開発に必要なものをインストールします。

開発環境に必要なソフトウェアは以下の2つです。

No. 開発環境 ソフトウェア 今回使用したバージョン 説明 1 python言語 Anaconda Anaconda Navigator 1.9.12 Anacondaは、Python言語の無料のオープンソースディストリビューションであり、パッケージ管理とデプロイメントの簡略化を狙ったものです。大変便利です。 2 IDE(統合開発環境) pycharm Community 2020.2版 コード解析やグラフィカルなデバッガが可能です。Community Editionは無料です。 ちなみにAIを動かすのに Keras というオープンソースのニューラルネットワークライブラリを使用します。

作業フロー

下記の表のNo.1 → 4 の順で実行していってください。

No. 作業概要 作業内容 説明 1 Anaconda設定 ①Download

②Install

③アプリ設定Kerasというオープンソースのニューラルネットワークライブラリを動かすため、Python言語を使えるようにします。 2 Pycharm設定 ①Download

②Install

③アプリ設定python言語での開発を簡単にし易くするため、統合開発環境を使えるようにします。 3 PythonによるAIプログラミング ①AIプログラミング

②ライブラリ追加

③AIプログラミング実行安心してください。プログラミングはしません。プログラムはコピペでOKです。 4 目的達成 思いにふける お疲れ様でした! 以上

- お疲れ様でした!

- 投稿日:2020-08-06T21:43:33+09:00

・<Slack>Slackに通知する関数を書いて、いつでも引用できるようにする(Python)

- 投稿日:2020-08-06T20:43:21+09:00

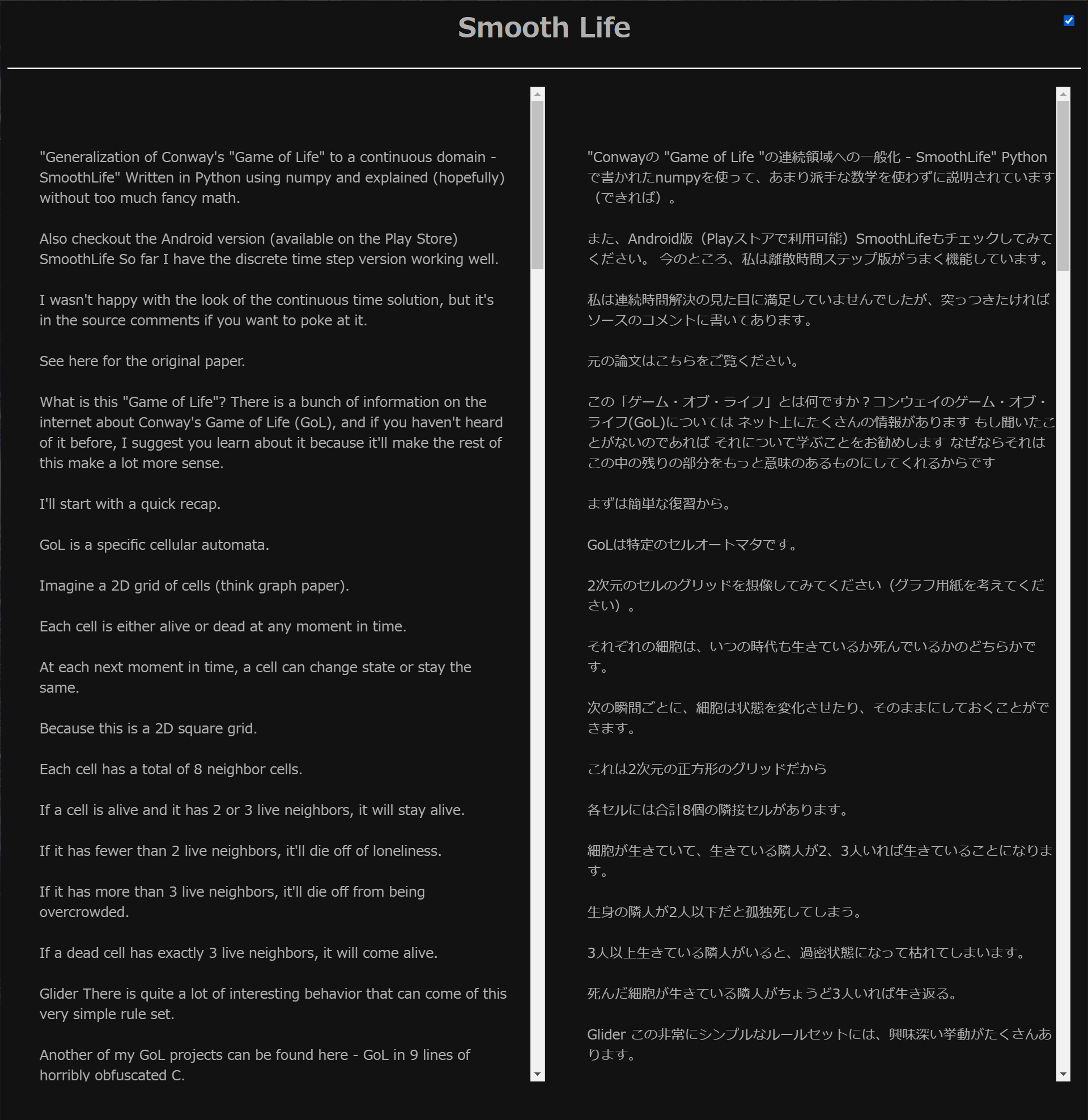

続【Python】英文PDF(に限らないけど)をDeepLやGoogle翻訳で自動で翻訳させてテキストファイル、いやHTMLにしてしまおう。

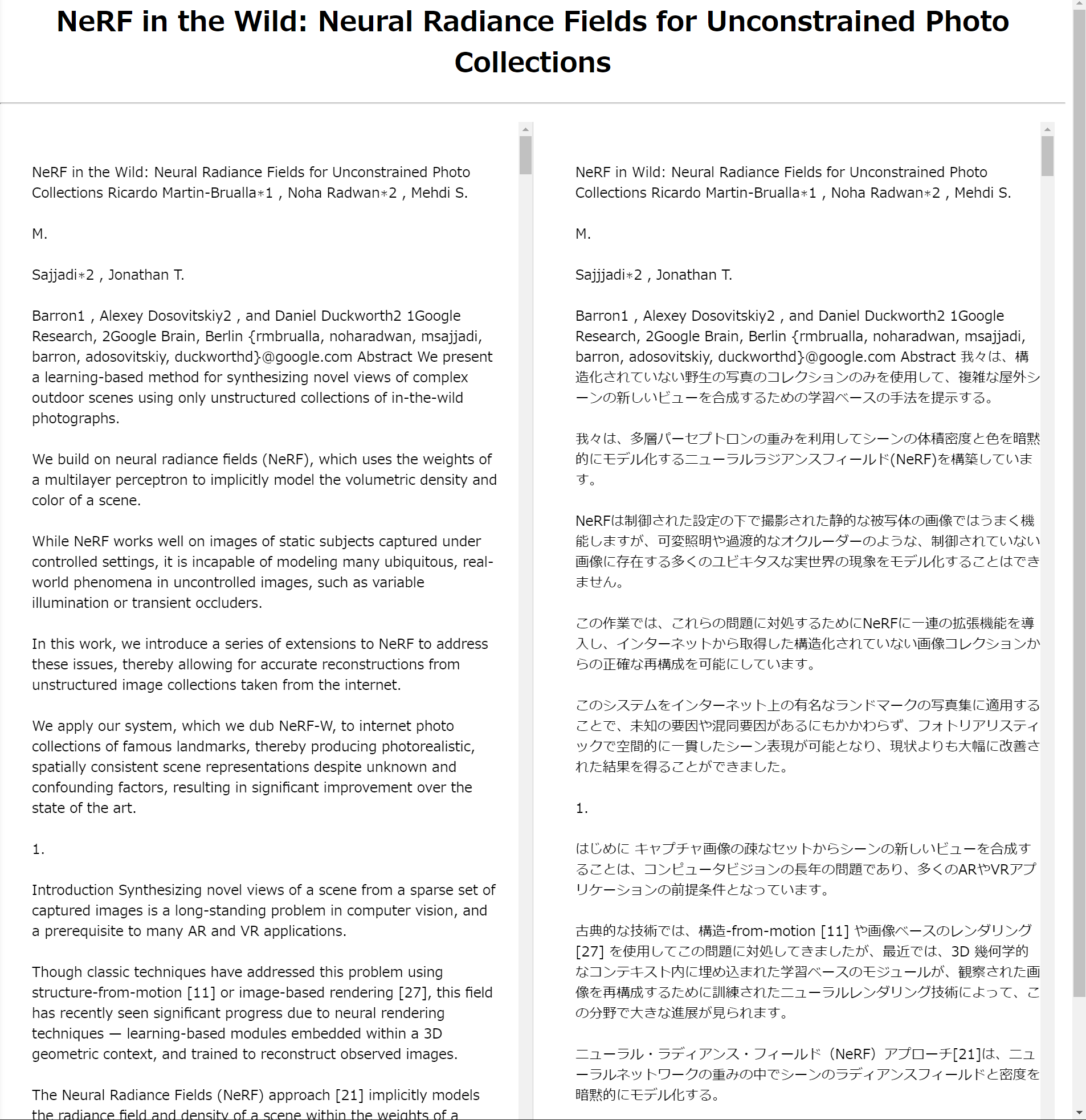

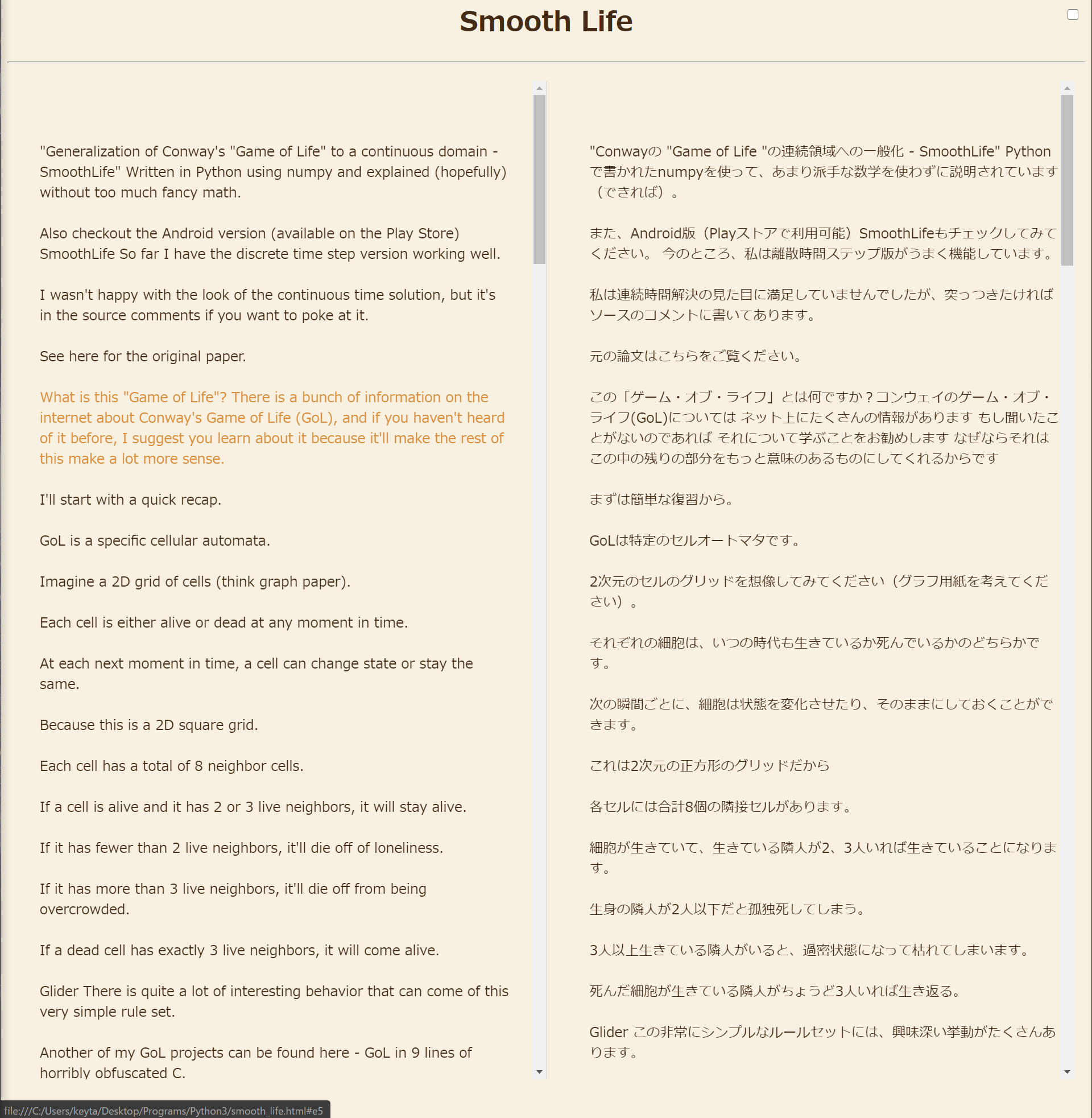

前回の内容と今回やったこと

前回の記事【Python】英文PDF(に限らないけど)をDeepLやGoogle翻訳で自動で翻訳させてテキストファイルにしてしまおう。

では翻訳結果をテキストファイルに出力しましたが、翻訳前の文章と横に並べて見比べられたら便利だと思いませんか。

まだ改善の余地はありますがHTMLで実現しました。

例に使った論文ごちゃごちゃと盛り付けたのでコードが汚いですがご容赦ください(もとからか)。

8/7追記

HTML表示時における

・ 対応する英文or和文への、ハイライト機能・ジャンプ機能

・ ダークモード

を追加しました。また、

非ダークモード時の色合いも優しくしました。逆翻訳(日本語 → 英語)に対応しました。

コード

from selenium import webdriver from selenium.webdriver.chrome.options import Options from selenium.webdriver.common.keys import Keys import time import pyperclip as ppc DRIVER_PATH = 'chromedriver.exe' options = Options() options.add_argument('--disable-gpu') options.add_argument('--disable-extensions') options.add_argument('--proxy-server="direct://"') options.add_argument('--proxy-bypass-list=*') options.add_argument('--start-maximized') def parse_merge(text, n=4900, m=1, inv=False): sentences = [] sentence = "" for j, i in enumerate(" ".join( text.split("\r\n")).split(". " if inv == False else "。")): if i in ("", " ", "."): continue if (len(sentence) + len(i) > n) or (j % m == 0): sentences.append(sentence) sentence = "" sentence += i + ("." if inv == False else "。") sentences.append(sentence) return sentences def TranslateFromClipboard(tool, write, filename, isPrint, html, title, sentence_cnt, inv): driver = webdriver.Chrome(executable_path=DRIVER_PATH, chrome_options=options) url = 'https://www.deepl.com/ja/translator' if tool == "DeepL" else f'https://translate.google.co.jp/?hl=ja&tab=TT&authuser=0#view=home&op=translate&sl=auto&tl={"en" if inv else "ja"}' driver.get(url) if tool == "DeepL": textarea = driver.find_element_by_css_selector( '.lmt__textarea.lmt__source_textarea.lmt__textarea_base_style') elif tool == "GT": textarea = driver.find_element_by_id('source') en = parse_merge(ppc.paste(), m=sentence_cnt, inv=inv) ja = [] for sentence in en: if sentence == "": ja.append("") continue cbText = ppc.paste() ppc.copy(sentence) textarea.send_keys(Keys.CONTROL, "v") ppc.copy(cbText) transtext = "" while transtext == "": time.sleep(1) if tool == "DeepL": transtext = driver.find_element_by_css_selector( '.lmt__textarea.lmt__target_textarea.lmt__textarea_base_style' ).get_property("value") elif tool == "GT": try: time.sleep(1) transtext = driver.find_element_by_css_selector( '.tlid-translation.translation').text except: pass if isPrint: print(transtext) ja.append(transtext) textarea.send_keys(Keys.CONTROL, "a") textarea.send_keys(Keys.BACKSPACE) driver.quit() if write: with open(filename + ".txt", "w", encoding='UTF-8') as f: f.write("\n".join(ja)) if html: eng = "" jpn = "" for i, ej in enumerate(zip(en, ja)): eng += f'<br><a id="e{i}" href="#j{i}" onmouseover="over(' + f"'j{i}'" + ')" onmouseout="out(' + f"'j{i}'" + f')">{ej[0]}</a><br>' jpn += f'<br><a id="j{i}" href="#e{i}" onmouseover="over(' + f"'e{i}'" + ')" onmouseout="out(' + f"'e{i}'" + f')">{ej[1]}</a><br>' with open(filename + ".html", "w", encoding='UTF-8') as f: f.write( f'<h1 align="center">{title}</h1>\n<input id="btn-mode" type="checkbox">\n<hr>\n<body>\n<div class="parent">\n<div id="en">\n{eng}\n</div>\n<div id="ja">\n{jpn}\n</div>\n</div>' + '<style>\n:root {\n--main-text: #452b15;\n--main-bg: #f8f1e2;\n--highlight-text: #db8e3c;\n}\n:root[theme="dark"] {\n--main-text: #b0b0b0;\n--main-bg: #121212;\n--highlight-text: #fd8787;\n}\nh1 {\ncolor: var(--main-text);\n}\ninput {\nposition: absolute;\ntop: 1%;\nright: 1%;\n}\n#en {\nwidth: 45%;\nheight: 90%;\npadding: 0 2%;\nfloat: left;\nborder-right:1px solid #ccc;\nmargin: 1%;\noverflow: auto;\n}\n#ja {\nwidth: 45%;\nheight: 90%;\nfloat: right;\nmargin: 1%;\noverflow: auto;\n}\na,\na:hover,\na:visited,\na:link,\na:active {\ncolor: var(--main-text);\ntext-decoration: none;\n}\nbody {\nbackground-color: var(--main-bg);\n}\n</style>\n<script>\nvar a = document.getElementsByTagName("a");\nfunction over(e) {\ndocument.getElementById(e).style.color = getComputedStyle(document.getElementById(e)).getPropertyValue("--highlight-text");\n}\nfunction out(e) {\ndocument.getElementById(e).style.color = getComputedStyle(document.getElementById(e)).getPropertyValue("--main-text");\n}\nconst btn = document.querySelector("#btn-mode");\nbtn.addEventListener("change", () => {\nif (btn.checked == true) {\ndocument.documentElement.setAttribute("theme", "dark");\n} else {\ndocument.documentElement.setAttribute("theme", "light");\n}\nfor (var i = 0; i < a.length; i++) {\na[i].style.color = getComputedStyle(a[i]).getPropertyValue("--main-text");\n}\n});\n</script>\n</body>' ) if __name__ == "__main__": args = [ "DeepL", False, "translated_text.txt", True, False, "EN ↔ JP", 1, False ] if input("1. 英語 → 日本語 2. 日本語 → 英語 ") == "2": args[7] = True if input("1. DeepL 2.GoogleTranslate ") == "2": args[0] = "GT" if input("翻訳結果を書き出しますか? y/n ") == "y": case = input("1. txt 2. HTML 3. both ") if case == "1": args[1] = True format_ = ".txt" elif case == "2": args[4] = True format_ = ".html" elif case == "3": args[1], args[4] = True, True format_ = ".txt/.html" filename = input( f"出力ファイルにつける名前を入力してください(デフォルトは'translated_text{format_}') ") if filename: args[2] = filename if case == "2" or case == "3": title = input("(論文の)タイトルを入力してください ") if title: args[5] = title try: args[6] = int( input("何文ずつ翻訳しますか?(デフォルトは1文ずつ。小さいほど出力がきれいで、大きいほど早くなります。) ")) except: pass if input("翻訳経過をここに表示しますか? y/n ") == "n": args[3] = False input("準備ができたらEnterを押してください") TranslateFromClipboard(*args)読みやすさはかなり上がりましたが、1文ずつ翻訳しているので全文翻訳するのにかなり時間がかかります(実行時の選択でまとめて翻訳することも出来ます)。

まとめ

HTMLやCSSはズブの素人なのでこうしたらもっと良くなる!という点があればご教示いただけると嬉しいです。

- 投稿日:2020-08-06T20:29:04+09:00

Nginx+uWSGI+Flask+Ubuntuで作る本格サーバー(実装編)

インストール編からの続き

各アプリケーションのざっくりとした説明とインストールは

前回の記事を参照Flask

以下の構造になるようなファイルを作っていく

flask_web_application/ ├── application/ │ ├── __init__.py │ └── views.py └── server.pyまずappというFlaskの本体を作成

__init__.pyfrom flask import Flask app = Flask(__name__) import application.viewsルートディレクトリにアクセスしたら

"Hello, World"とだけ返すviews.pyfrom application import app @app.route('/') def show_entries(): return "Hello World"uWSGIが実行するファイル

ようするにここから処理がスタートserver.pyfrom application import app if __name__ == "__main__": app.run(host='0.0.0.0')ちなみに今回は

/home/ubuntu/application/に作ったが

他のディレクトリの場合は

uWSGIを実行するユーザーにchownで権限を渡し

chmodで権限を「775」あたりにしておくこと

後々説明するが今回はuWSGIをグループ名:www-data

ユーザー名:www-dataで実行している

uWSGI

まずuwsgi.iniを作成

uwsgi.iniはuwsgiを起動するときに読み込む設定ファイル起動時に読み込むだけのものなのでどこに置いてもいいが

わかりやすく今回作っているFlaskアプリケーション

の直下にでも置いとくuwsgi.ini[uwsgi] base = /home/ubuntu/application/flask_web_application module = server:app virtualenv = /home/ubuntu/py36_flask_server pythonpath = %(base) callable = app uid = www-data gid = www-data master = true processes = 1 threads = 1 socket = /tmp/uwsgi.sock chmod-socket = 666 vacuum = true die-on-term = true thunder-lock = true主要な部分だけ

変数 説明 base アプリケーションのディレクトリ module app = Flask(__name__)で作ったappのこと virtualenv Pythonの仮想環境のディレクトリ pythonpath baseと同じ callable 呼び出すモジュール(app) uid ユーザー名で実行 gid グループ名で実行 processes 環境とアプリケーションによるがコア数がおすすめ threads Flaskが使うスレッドの数、Flaskをマルチスレッドで実行すること自体おすすめしない(GIL問題) socket UNIXドメインソケット uid、gidで指定するユーザー名・グループ名はあらかじめ作っておく

www-dataなら既に存在しているはず

指定しないとrootで実行することになるのでセキュリティ上あまりよろしくないそのた諸々、参考になる記事

https://uwsgi-docs.readthedocs.io/en/latest/ThingsToKnow.html

https://qiita.com/yasunori/items/64606e63b36b396cf695

https://qiita.com/wapa5pow/items/f4326aed6c0b63617ebd

https://qiita.com/11ohina017/items/da2ae5b039257752e558uWSGIをサービスに追加

$ sudo vi /etc/systemd/system/uwsgi.service #下記を追加 [Unit] Description=uWSGI After=syslog.target [Service] ExecStart=/home/ubuntu/py36_flask_server/bin/uwsgi --ini /home/ubuntu/application/flask_web_application/uwsgi.ini # Requires systemd version 211 or newer RuntimeDirectory=uwsgi Restart=always KillSignal=SIGQUIT Type=notify StandardError=syslog NotifyAccess=all [Install] WantedBy=multi-user.targetExecStartに仮想環境にインストールしたuWSGIを

--iniに先ほど作った設定ファイルを指定しますサービスにuWSGIを追加

$ sudo systemctl enable uwsgiNginx

デフォルトのNginxウェルカムページを消す

conf.d/default.confがあるなら削除

$ sudo rm /etc/nginx/conf.d/default.conf/nginx/sites-enabled/defaultがあるなら削除

$ sudo rm /etc/nginx/sites-enabled/defaultこれでデフォルトサイトは消える

sites-availableとsites-enabledがない場合作成しておく

$ sudo mkdir /etc/nginx/sites-available $ sudo mkdir /etc/nginx/sites-enabledsites-available と sites-enabledは結局なんなのか

基本的には一つのサーバーで複数のドメインを使うためのもので

管理がしやすくなるただ今回は別に複数のドメインを使うわけではないのだが

Ubuntu+Nginx+uWSGIという構造上

conf.dを使うより安定する使い方は

・sites-availableにドメイン別の設定ファイルを作成

・sites-enabledにsites-availableのシンボリックリンクを張るという至って簡単なもの

シンボリックリンクはいわゆるショートカット/etc/nginx/nginx.confのhttpブロック部分の

/etc/nginx/conf.d/*.confを書き換える$ sudo vi /etc/nginx/nginx.conf http{ … include /etc/nginx/conf.d/*.conf; }↓

http{ … include /etc/nginx/sites-enabled/*; }/etc/nginx/sites-available/myapplication.confを追加

$ sudo vi /etc/nginx/sites-available/myapplication.conf # 下記を追加 server { listen 80; root /var/www/html; location / { try_files $uri @yourapplication; } location @yourapplication { include uwsgi_params; uwsgi_pass unix:///tmp/uwsgi.sock; } }ざっくり説明するとtry_filesでURLそのままを

rootから検索、なかったらuWSGIに(URLそのままで)内部リダイレクトするという構造

rootは特になにも入っていない

全部uWSGIに丸投げしてもいいのだけど公式は上記みたいになっているuwsgi_paramsはuWSGIの設定ファイル

unix:///tmp/uwsgi.sockはUNIXドメインソケット

といわれるものでようするにこれでuWSGIとの通信を行う他にTCPで接続したりもできるがポートを占領してしまうので

ドメインソケットを使った方がよいショートカットを作ればnginxの設定は終わり

$ sudo ln -s /etc/nginx/sites-available/myapplication.conf /etc/nginx/sites-enabled/myapplicationアクセス

ここらへんで一旦システムごと再起動することを推薦

できない場合はNginxだけは再起動する$ sudo systemctl restart nginxuwsgiを起動していないなら起動

& sudo systemctl start uwsgiuwsgiのエラーチェック

$ sudo systemctl status uwsginginxのエラーチェック

$ sudo systemctl status nginx一通り読んでエラーがなさそうならアクセスしてみる

$ curl http://127.0.0.1 Hello, Worldまとめ

基本的に静的ファイルはNginxに処理させた方が早い

間違っているこうした方がよいという箇所があったら教えてください

- 投稿日:2020-08-06T20:27:25+09:00

class名をインスタンスを作らずに取得する

概要

クラスオブジェクト自身からclass名を取得する方法が書いてある日本語の記事がなかったので、備忘録として書いておきます。

class名を取得する方法

インスタンスから取得する

ググってもほとんどがこの方法を使って取得していました。

class A: pass a = A() print(a.__class__.__name__) >>> Aクラスオブジェクト自身から取得する

Python3.3から実装された

__qualname__で取得できます。

追記:B.__name__でも取得できるようです。@shiracamusさん、ありがとうございます。

また、__qualname__はクラスオブジェクト内ではB.__qualname__ではなく単純に__qualname__とだけでも書けます。class B: pass print(B.__qualname__) >>> B # 追記 class C: qualname = __qualname__ print(C.__name__) print(C.qualname) >>> C >>> Cおわりに

__qualname__なら、クラスオブジェクト内やクラスオブジェクトを引数に取る関数の中でも取得できますね。

追記:先ほど追記した通り、__name__を使っても取得できるようです。参考文献

- 投稿日:2020-08-06T20:27:08+09:00

[cx_Oracle入門](第16回) LOB型の取り扱い

連載目次

検証環境

- Oracle Cloud利用

- Oracle Linux 7.7 (VM.Standard2.1)

- Python 3.6

- cx_Oracle 8.0

- Oracle Database 19.6 (DBCS HP, 2oCPU)

- Oracle Instant Client 18.5

事前準備

以下のテーブルを作成しておいてください。

SQL> create table sample16(col1 number, col2 blob);LOB型への参照・更新の基本

データが1GBまでであれば、CLOB型であればstr、BLOBであればbyteとして、VARCHAR2型やRAW型のように特段の考慮なく扱えます。1GBを超える場合は一定量ずつ処理するストリーム処理の形式で処理する必要があります。ストリームを介さない方がパフォーマンスには優れますが、1件は1GBに満たないデータであっても、fetchmany()とかするとあっという間にメモリを食いつぶしますので、メモリリソースとフェッチするデータ量(平均サイズ×レコード件数)との兼ね合い次第では、小規模サイズのLOBであってもストリーム処理を検討して下さい。

小規模なデータの更新

全ケースにて、処理対象のデータ(ファイル)は別途ご用意ください。サンプルソースを自環境で動かしてみる場合は、ソース内のファイル名もしくは用意したファイルの名称のどちらかを修正してください。以下、BLOB型へのINSERTのサンプルです。

sample16a.pyimport cx_Oracle USERID = "admin" PASSWORD = "FooBar" DESTINATION = "atp1_low" SQL = """ insert into sample16 values(1, :blobdata) """ with open('screenshot1.png', 'rb') as f: image = f.read() with cx_Oracle.connect(USERID, PASSWORD, DESTINATION) as connection: with connection.cursor() as cursor: cursor.execute(SQL, blobdata=image) cursor.execute("commit")小規模なデータの参照

参照は更新ほど簡単ではなく、第9回に解説したoutputtypehandlerを定義する必要があります。以下のサンプルは、先に登録したレコードを参照して、異なる名称のファイルに保存しています。

sample16b.pyimport cx_Oracle def OutputTypeHandler(cursor, name, defaultType, size, precision, scale): if defaultType == cx_Oracle.DB_TYPE_BLOB: return cursor.var(cx_Oracle.DB_TYPE_LONG_RAW, arraysize=cursor.arraysize) USERID = "admin" PASSWORD = "FooBar" DESTINATION = "atp1_low" SQL = """ select col2 from sample16 where col1 = 1 """ with cx_Oracle.connect(USERID, PASSWORD, DESTINATION) as connection: connection.outputtypehandler = OutputTypeHandler with connection.cursor() as cursor: cursor.execute(SQL) lobdata, = cursor.fetchone() with open('screenshot2.png', 'wb') as f: f.write(lobdata)なお、当然ながら、両ファイルの内容は同じです。

$ cmp screenshot1.png screenshot2.png $大規模なデータの更新

BLOBをベースに解説します。おおよそ以下の手順になります。

- LOB列にSQL関数のEMPTY_BLOB()で空のロケータを挿入

- INSERT文のRETURNING句でLOBロケータをバインド

- LOBロケータに対してストリームでデータを流し込む

sample16c.pyimport cx_Oracle USERID = "admin" PASSWORD = "FooBar" DESTINATION = "atp1_low" SQL = """ insert into sample16 values(2, empty_blob()) returning col2 into :blobdata """ # [1.] with cx_Oracle.connect(USERID, PASSWORD, DESTINATION) as connection: with connection.cursor() as cursor: blobdata = cursor.var(cx_Oracle.DB_TYPE_BLOB) # [2.] cursor.execute(SQL, [blobdata]) blob, = blobdata.getvalue() offset = 1 bufsize = 65536 # [3.] with open('screenshot1.png', 'rb') as f: # [4.] while True: data = f.read(bufsize) if data: blob.write(data, offset) if len(data) < bufsize: break offset += bufsize connection.commit()以下、コメントの番号に対応しています。

- BLOB列にはSQL関数のEMPTY_BLOB()を使用して空のLOBロケータを挿入しています。そして、RETURNING句を使用して、挿入した空のLOBロケータをバインド変数で受けます。

- バインド変数に対応するPython側の変数を用意します。Cursor.var()を使用してBLOBであることを指定しています。

- バッファのサイズを指定しています。

- オープンしたファイルを3.のサイズ分ずつLOBロケータを介してLOB列に書き込んでいます。

UPDATE文でも、SQL文が変わるだけで流れは同じです。LOB列をEMPTY_BLOB()で更新してください。

大規模なデータの参照

BLOBをベースに解説します。おおよそ以下の手順になります。更新よりは簡単です。

- SELECTリストのLOB列(LOBロケータ)をバインド

- LOBロケータに対してストリームでデータを読み込む

sample16d.pyimport cx_Oracle USERID = "admin" PASSWORD = "FooBar" DESTINATION = "atp1_low" SQL = """ select col2 from sample16 where col1 = 2 """ # [1.] with cx_Oracle.connect(USERID, PASSWORD, DESTINATION) as connection: with connection.cursor() as cursor: cursor.execute(SQL) blob, = cursor.fetchone() offset = 1 bufsize = 65536 # [2.] with open('screenshot3.png', 'wb') as f: # [3.] while True: data = blob.read(offset, bufsize) if data: f.write(data) if len(data) < bufsize: break offset += bufsize以下、コメントの番号に対応しています。

- BLOB列をSELECTします。

- バッファのサイズを指定しています。

- オープンしたファイルに、LOBのデータを2.のサイズ分ずつ書き込んでいます。

- 投稿日:2020-08-06T20:26:42+09:00

Nginx+uWSGI+Flask+Ubuntuで作る本格サーバー(インストール編)

複雑になりがちなFlaskを用いたサーバーをインストールから

実装は実装編で

登場人物

Nginx

Webサーバー

基本的にクライアントからの接続はこいつを

通してから処理される

いわば元請けuWSGI

アプリケーションサーバー

今回はWebサーバー(Nginx)とWebアプリケーション(Flask)

とを繋ぐ橋渡し役

いわば中間業者そもそもWSGIとは?

WebServerGatewayInterfaceの略(ウィスキーと読むらしい)

Webアプリケーション(Flask)とWebサーバー(Nginx)間の取り決めのこと

ようするにプロトコル(仕様)これがないと

例えばあるWebサーバー(A)を使った場合

その仕様に乗っ取ったWebアプリケーション(A')

を使わなければいけないことになる(現に昔はそうしてたらしい)

逆もまたしかりその仕様を標準化した形がWSGIということ

当たり前だがこれから使うFlaskもWSGIの仕様に乗っ取ってるFlask

ウェブアプリケーションフレームワーク

実際の処理はこいつが行う

いわば下請けPythonの主要なフレームワークとしてDjangoがあるが

Djangoと比べると必要最低限の機能しか搭載してないので

超軽量かつ簡単に実装できてしまうNetflixやRedditなどが使っている

Virtualenv

Pythonの仮想環境

システムがパッケージで混雑になることを防止

なくても実装はできるがあった方がよい事前準備

リポジトリをアップデート

$ sudo apt updateパッケージの更新

$ sudo apt upgradegcc,gdbなどの開発ツールをインストールしておく(uwsgiのビルドに必要)

$ sudo apt install build-essentialopensslをインストール

$ sudo apt install opensslpip3をインストール

$ sudo apt install python3-pipファイアウォール

ファイアウォールの設定

ubuntu側でもファイアウォールを設定しておく

必要ないと思ったら飛ばしてOKufwをインストール

$ sudo apt install ufwすべてのポートを閉じる

$ sudo ufw default deny必要なポートは開けておく

自分の場合はSSH(22), http(80)$ sudo ufw allow 22 $ sudo ufw allow 80ファイアウォールを有効化

& sudo ufw enableステータスを確認

$ sudo ufw statusちなみにSSHで接続している場合

この順番を守らないと接続できなくなる

可能性があるので注意Nginx

最新版のnginxを入れる方法は

https://nginx.org/en/linux_packages.html

https://xn--o9j8h1c9hb5756dt0ua226amc1a.com/?p=3100

から別に最新版を入れる必要はないならインストールまで

飛ばしてOKPGPキーをダウンロード

$ wget https://nginx.org/keys/nginx_signing.keyキーをインポート

$ sudo apt-key add nginx_signing.keyリポジトリを登録

$ sudo vi /etc/apt/sources.list # 末尾に追加 bionicの部分はubuntuの開発コード deb http://nginx.org/packages/ubuntu/ bionic nginx deb-src http://nginx.org/packages/ubuntu/ bionic nginx~/ubuntu/bionic nginxのbionicの部分は

Ubuntuのバージョンによって書き換える

バージョン 開発コード 16.04 xenial 18.04 bionic 19.10 eoan 20.04 focal ubuntuのversion確認方法は

$ cat /etc/lsb-release DISTRIB_RELEASE=18.04 DISTRIB_CODENAME=bionicリポジトリ情報を更新

sudo apt updateバージョンを確認

$ apt show nginx Package: nginx Version: 1.18.0-1~bionic記事を書いてる時点で1.18.0が安定版らしい

http://nginx.org/en/download.html

で最新版かどうか確認できる---ここまでが最新版を入れる方法---

インストール

$ sudo apt install nginxバージョン確認

$ nginx -v nginx version: nginx/1.18.0あらかじめサービスに登録しておく

$ sudo systemctl enable nginx $ sudo systemctl start nginxアクセスできれば成功

$ curl http://localhost <!DOCTYPE html> <html> <head> <title>Welcome to nginx!</title> ...80番ポートが開いているなら

許可されてるIPから$ curl http://<パブリックIP>でも確認しておく

Virtualenv

pip3でインストール

$ sudo pip3 install virtualenvバージョン確認

$ virtualenv --version環境を作成

$ virtualenv py36_flask_server --python=python3.6ちなみに指定したバージョンのPythonが入っていない場合

作成に失敗するので事前にインストールしておく下記で環境に入れればOK

$ . <環境名>/bin/activate (py36_flask_server) ubuntu@ip-10-0-0-14:~$uWSGI

virtualenvで作成した環境からpip3でインストール

$pip3 install uwsgiバージョンを確認

$uwsgi --versionちなみにVirtualenvではなくAnacondaを使うという手もあった

ただuWSGIをインストールする段階でエラーが多発するので注意Anacondaを使いたい場合

時間はかかるが解決はするので下記の記事を参考

https://katsuwosashimi.com/archives/300/python-conda-install-uwsgi-failed/Flask

virtualenvで作成した環境からpipでインストール

$pip3 install flask以上

まとめ

インストールの段階でだいぶ長くなってしまった

次は実装編で

- 投稿日:2020-08-06T20:03:36+09:00

【Python, PyPDF2】見開きのPDFを左右に2分割するスクリプト

今回の内容

PyPDF2を使って、見開きでスキャンした資料などのpdfファイルを左右に2分割するスクリプトのメモです。

ソースコード

from PyPDF2 import PdfFileWriter, PdfFileReader import copy def split_pdf(input_pdf, output_filename): pdf_file = PdfFileReader(open(input_pdf, 'rb')) marged = PdfFileWriter() page_num = pdf_file.getNumPages() for i in range(0, page_num): page_L = pdf_file.getPage(i) page_R = copy.copy(page_L) (w, h) = page_L.mediaBox.upperRight page_L.mediaBox.upperRight = (w/2, h) marged.addPage(page_L) page_R.mediaBox.upperLeft = (w/2, h) marged.addPage(page_R) outputStream = open(output_filename, "wb") marged.write(outputStream) outputStream.close() def sample(): input_pdf = "input.pdf" output_filename = "output.pdf" split_pdf(input_pdf, output_filename) if __name__ == "__main__": sample()使い方

split_pdf()に対して、分割するpdfファイルと、出力する際のファイル名を与えることでpdfファイルを2分割します。

簡単な解説

一つのページを左ページ用と右ページ用に2つ用意します。(page_L, page_R)

ページは左下を始点とするので、右上の座標から横幅と高さを取得します。(w, h)

左ページには右側の、右ページには左側の座標を指定することで、それを基準にそれぞれ切り取ります。

今回は、左ページには右上の座標を (w/2, h)、右ページには左上の座標を (w/2, h)として指定し、左右に2分割しています。

蛇足、右ページについては

page_R.mediaBox.lowerLeft = (w/2, 0)とした方が分かりやすいのかもしれません。使い方の例

自分は以下のように使っています。追加、変更分のみ書きます。

import sys, os def main(): argv = [sys.argv[i] for i in range(1,len(sys.argv))] for input_pdf in argv: basename_without_ext = os.path.splitext(os.path.basename(input_pdf))[0] output_filename = "split_{}.pdf".format(basename_without_ext) print("{}を2分割します。".format(os.path.basename(input_pdf))) split_pdf(input_pdf, output_filename) if __name__ == '__main__': main()引数を取得して、for文で回してsplit_pdfに渡します。出力ファイル名は入力ファイル名の先頭にsplit_を付けたものになります。

参考にさせていただいたもの

- 投稿日:2020-08-06T20:00:48+09:00

Windows の Atom で Pylint

本題

C:\Users\<ユーザー名>\AppData\Roaming\Python\Python38\Scripts\pylint.exe

設定(

ctrl+,)> パッケージ > コミュニティパッケージ > linter-pylint > 設定 > Settings > Executable Pathに上記のパスを設定する。Pythonのバージョンとかは適宜変更してください。おまけ

概要

Atomのセットアップするたびに躓くので設定手順を書き残しておこうと思いました。

インストール

Atomのパッケージ(linter-pylint)は、Atom内でインストールすればいいと思う。

setup_pylint_atom.shpip install pylint apm install linter-pylint環境

- Windows Home 10 2004

- Atom 1.49.0

- linter-pylint 2.1.1

- Python 3.8.5

- python.org からダウンロード

- 全ユーザーにインストール

- PATH追加済み

- pylint 20.2.1

さいごに

解決しましたか?

- 投稿日:2020-08-06T19:52:01+09:00

データの水増し(DataAugmentation)をopenCVで

はじめに

8月に入り激アツな日々皆さんいかがお過ごしですか?

私はいまにも溶けそうな勢いでありますが米津玄師の新曲を聞きながら

冷房の効いた昼夜がわからない部屋でコーディングをしてるわけですが皆さん夏と言ったらなんですか?

- 夏祭り?

- 花火?

- かき氷?いや夏と言ったらDataAugmentationの夏ですよ!!!

ということでopenCVでちゃちゃっとDataAugmentationする方法をメモ代わりに書いときます。誰向けなの

- 大量のデータをディレクトリ構造を維持したままDataAugmentationしたい人!

- とりあえず早くデータを作らないと誰かに怒られる人

- プログラム組むのが面倒な人!

- 以下のコマンドで実行

python3 img_change.py input_directory output_directory- 例

python3 img_change.py /data/imageset /data/imagser_changeプログラム

img_change.py# -*- coding: utf-8 -*- import numpy as np import os import cv2 import sys import pathlib import glob from scipy.signal import qspline1d, qspline1d_eval, qspline2d,cspline2d if len(sys.argv) != 3: print("python3 test.py inputdir outputdir") sys.exit() else: input_path = sys.argv[1] file_list = glob.glob(input_path + "/**/**.png", recursive=True) for item in file_list: split_name = item.split('/') output_name = sys.argv[2] + "/" + split_name[-3] + "/" + split_name[-2] + "/" + split_name[-1] output_dir = sys.argv[2] + "/" + split_name[-3] + "/" + split_name[-2] pathlib.Path(output_dir).mkdir(parents=True,exist_ok=True) img = cv2.imread(item, cv2.IMREAD_UNCHANGED) # read image #画像処理部分 ###画像の輝度を上げる chg_img=img*1.2 #輝度が2倍になる ###画像のリサイズ height = img.shape[0] #img.shape[0]*0.5でもとの半分のサイズ width = img.shape[1] chg_img = cv2.resize(img , (int(width), int(height))) ###CLAHE(ヒストグラムができるだけ均等にバラけるように再配分) clahe = cv2.createCLAHE(clipLimit=2.0, tileGridSize=(8,8)) chg_img = clahe.apply(img) ###ノイズ row,col,ch = img.shape # 白 pts_x = np.random.randint(0, col-1 , 1000) #0から(col-1)までの乱数を千個作る pts_y = np.random.randint(0, row-1 , 1000) img[(pts_y,pts_x)] = (255,255,255) #y,xの順番になることに注意 # 黒 pts_x = np.random.randint(0, col-1 , 1000) pts_y = np.random.randint(0, row-1 , 1000) img[(pts_y,pts_x)] = (0,0,0) ###画像を歪める chg_img = cv2.flip(img, 1) #水平方向に反転 chg_img = cv2.flip(img, 0) #垂直方向に反転 cv2.imwrite(output_name,chg_img ) #write image

- 上のプログラムでは以下のディレクトリ構造でプログラムを作成している

$ tree /data └── val ├── A1 │ │ │ ├── 0.png │ ├── 1.png │ ├── 2.png │ └── .... ├── B1 │ │ │ ├── 0.png │ ├── 1.png │ ├── 2.png │ └── .... │ train ├── A1 │ │ │ ├── 0.png │ ├── 1.png │ ├── 2.png │ └── .... ├── B1 │ │ │ ├── 0.png │ ├── 1.png │ ├── 2.png │ └── .... │ test ├── A1 │ │ │ ├── 0.png │ ├── 1.png │ ├── 2.png │ └── .... ├── B1 │ │ │ ├── 0.png │ ├── 1.png │ ├── 2.png │ └── .... │ └──

- よって指定したディレクトリの2つ下のディレクトリの.pngをすべてリストとして取得する感じ

終わりに

- 色々画像の変える方法はあるのでOpenCV画像加工とかで調べて見てね

- 参考サイトPythonで画像処理② Data Augmentation (画像の水増し)

- 投稿日:2020-08-06T19:39:24+09:00

【Discord.py】Cogをついて理解する

僕がDiscord.pyのCogについて勉強したのでそのメモと、「リファレンス読んでもわからな~い!!」という人がいるのでその人たちのために書きました。

注意:これはCogの解説です。Discord.pyをまだマスターしていない人は、先にそちらをマスターしてから見ください。

Cog(コグ)とは??

そもそもCogって何??

Bot開発においてコマンドやリスナー、いくつかの状態を一つのクラスにまとめてしまいたい場合があるでしょう。コグはそれを実現したものです。

Discord.pyのドキュメントに書いてありますが、これを見ても「意味不状態」になる人がいるのではないでしょうか?(僕もそうでしたw)

Cogを応用することでDiscord.pyのファイルを2ファイル以上に分けることができたり、Botを起動中にもファイルを簡単に再読み込みすることができたりします!!

Cogの書き方

コマンド

Cogを使わないときはコマンドを定義するさいに以下のように書きますが、

@bot.command() async def test(ctx): pass #実行内容Cog内でコマンドを定義するときは以下のように書きます。

@commands.command() async def test(self,ctx): pass #実行内容違いは

@bot.~が@commands.~なったのと、引数にselfが追加されたことぐらいですかね(表面的なところは)イベント

Cogを使わないときはイベントを定義するさいに以下のように書きますが、

@bot.event async def on_ready(): pass #実行内容Cog内でイベントを定義するときは以下のように書きます。

@commands.Cog.listener() async def on_ready(self): pass #実行内容違いは

@bot.eventが@commands.Cog.listener()になったことと、さっきと同じように引数にselfが追加されたことですね。変数

Botの使い方Cogを使わないときはBotの名前を表示するさいに以下のように書きますが、

print(bot.user)Cog内で使うときは以下のようになります。

print(self.bot.user)違いは

selfを書かなければいけなくなったってことぐらいですね。Cogの追加

同じファイルのとき

まずは同じファイルのCogを呼び出してみましょう。

main.pyimport discord from discord.ext import commands bot = commands.Bot(command_prefix="!") class Greetings(commands.Cog): def __init__(self, bot): self.bot = bot self._last_member = None @commands.command() async def test(self,ctx): await ctx.send("test!") bot.add_cog(Greetings(bot))こんな感じになります。

つまり、Cogはbot.add_cog(Class名(bot))で読み込みます!!別ファイルのとき

. ┣━main.py ┗━sub.pyもし、ファイルディレクトリが上のようになっていて

sub.pyにあるClassGreetingsを読み込みたいときは以下のようにすることで読み込めます!!main.pyimport discord from discord.ext import commands bot = commands.Bot(command_prefix="!") import sub bot.add_cog(sub.Greetings(bot))まず、

import subでsub.pyを読み込んで、bot.add_cog(sub.Greetings(bot))でsub.py内にあるGreetingsを読み込んでいます!!上以外のディレクトリの場合

上以外のディレクトリの場合も同じように

importを使うことで読み込みできます。

詳しくは、「Python 3でのファイルのimportのしかたまとめ」を見てください。Extensionって何??

Extensionとは上でも言いましたが、Botを起動中にもファイルを簡単に再読み込みすることができるようになる機能のことです。

Extensionを使うことで、

importを使ってファイル指定をせずに済むようになります。例

. ┣━ main.py ┗━ sub.pyファイルディレクトリが上のようになっている場合、以下のようにすることで

sub.pyのGreetingsを読み込むことができます!!main.pyimport discord from discord.ext import commands bot = commands.Bot(command_prefix="!") bot.load_extension("sub")sub.pyimport discord from discord.ext import commands class Greetings(commands.Cog): def __init__(self, bot): self.bot = bot self._last_member = None @commands.command() async def test(self,ctx): pass def setup(bot): return bot.add_cog(Greetings(bot))ファイルの読み込み

bot.load_extension()