- 投稿日:2020-05-15T23:51:32+09:00

SwiftでN次元行列演算ライブラリを作ってみた

はじめに

初投稿です.

タイトルの通りなのですが,SwiftでN次元行列演算ライブラリMatftを作ってみました.(Mat rix演算をする・Swi ftで,の略でMatftです笑)事の発端は,会社の先輩の「Swiftで3行3列の逆行列を求めるコードを書いてほしい」という一言でした.

SwiftにはPythonのNumpyのようなN次元行列演算ライブラリがあるだろうと思ったのですが,調べると意外にもないんですよね...

公式のAccelerateは使い勝手悪そうだし,有名らしいsurgeも2次元まで?みたいでした.そんなこんなで,せっかくなので自作のN次元行列演算ライブラリを作ってみようと思いました.(3行3列の逆行列を求めるコードに対して,完全にオーバースペックですが笑)さらにそんなこんなで,Matftができました.そしてせっかくなので共有してみようということで,現在に至ります.

概要

基本的にはPythonのNumpyにならって作成したので,関数名や使い方はNumpyとほぼ同じです.

宣言

宣言は

ndarrayなるMfArrayで多次元配列を生成します.let a = MfArray([[[ -8, -7, -6, -5], [ -4, -3, -2, -1]], [[ 0, 1, 2, 3], [ 4, 5, 6, 7]]]) print(a) /* mfarray = [[[ -8.0, -7.0, -6.0, -5.0], [ -4.0, -3.0, -2.0, -1.0]], [[ 0.0, 1.0, 2.0, 3.0], [ 4.0, 5.0, 6.0, 7.0]]], type=Float, shape=[2, 2, 4] */型

いろいろな型に対応させたかったので,それなりの型を用意しました.

dtypeならぬMfTypeです.let a = MfArray([[[ -8, -7, -6, -5], [ -4, -3, -2, -1]], [[ 0, 1, 2, 3], [ 4, 5, 6, 7]]], mftype: .Float) print(a) /* mfarray = [[[ -8.0, -7.0, -6.0, -5.0], [ -4.0, -3.0, -2.0, -1.0]], [[ 0.0, 1.0, 2.0, 3.0], [ 4.0, 5.0, 6.0, 7.0]]], type=Float, shape=[2, 2, 4] */ let aa = MfArray([[[ -8, -7, -6, -5], [ -4, -3, -2, -1]], [[ 0, 1, 2, 3], [ 4, 5, 6, 7]]], mftype: .UInt) print(aa) /* mfarray = [[[ 4294967288, 4294967289, 4294967290, 4294967291], [ 4294967292, 4294967293, 4294967294, 4294967295]], [[ 0, 1, 2, 3], [ 4, 5, 6, 7]]], type=UInt, shape=[2, 2, 4] */ //Above output is same as numpy! /* >>> np.arange(-8, 8, dtype=np.uint32).reshape(2,2,4) array([[[4294967288, 4294967289, 4294967290, 4294967291], [4294967292, 4294967293, 4294967294, 4294967295]], [[ 0, 1, 2, 3], [ 4, 5, 6, 7]]], dtype=uint32)型一覧は以下のEnum型で定義しました.

※実を言うと,裏ではFloatかDoubleで保存しているので,UIntなんかは値が大きいとオーバーフローします.ただ,実用上は問題ないと思います.public enum MfType: Int{ case None // Unsupportted case Bool case UInt8 case UInt16 case UInt32 case UInt64 case UInt case Int8 case Int16 case Int32 case Int64 case Int case Float case Double case Object // Unsupported }Indexing

Numpyでいう

a[:, ::-1]のようなスライスも~で実装しました.

-1のような負のインデックスも実装しました.(これが一番苦労したかもしれません...)let a = Matft.mfarray.arange(start: 0, to: 27, by: 1, shape: [3,3,3]) print(a) /* mfarray = [[[ 0, 1, 2], [ 3, 4, 5], [ 6, 7, 8]], [[ 9, 10, 11], [ 12, 13, 14], [ 15, 16, 17]], [[ 18, 19, 20], [ 21, 22, 23], [ 24, 25, 26]]], type=Int, shape=[3, 3, 3] */ print(a[2,1,0]) // 21 print(a[1~3]) //same as a[1:3] for numpy /* mfarray = [[[ 9, 10, 11], [ 12, 13, 14], [ 15, 16, 17]], [[ 18, 19, 20], [ 21, 22, 23], [ 24, 25, 26]]], type=Int, shape=[2, 3, 3] */ print(a[-1~-3]) /* mfarray = [], type=Int, shape=[0, 3, 3] */ print(a[~~-1]) /* mfarray = [[[ 18, 19, 20], [ 21, 22, 23], [ 24, 25, 26]], [[ 9, 10, 11], [ 12, 13, 14], [ 15, 16, 17]], [[ 0, 1, 2], [ 3, 4, 5], [ 6, 7, 8]]], type=Int, shape=[3, 3, 3]*/その他関数一覧

ここからは,具体的な関数一覧です.主な計算はAccelerateに任せているので,計算時間はある程度担保されていると思います.

- 生成系

Matft Numpy Matft.mfarray.shallowcopy numpy.copy Matft.mfarray.deepcopy copy.deepcopy Matft.mfarray.nums numpy.ones * N Matft.mfarray.arange numpy.arange Matft.mfarray.eye numpy.eye Matft.mfarray.diag numpy.diag Matft.mfarray.vstack numpy.vstack Matft.mfarray.hstack numpy.hstack Matft.mfarray.concatenate numpy.concatenate

- 変換系

Matft Numpy Matft.mfarray.astype numpy.astype Matft.mfarray.transpose numpy.transpose Matft.mfarray.expand_dims numpy.expand_dims Matft.mfarray.squeeze numpy.squeeze Matft.mfarray.broadcast_to numpy.broadcast_to Matft.mfarray.conv_order numpy.ascontiguousarray Matft.mfarray.flatten numpy.flatten Matft.mfarray.flip numpy.flip Matft.mfarray.swapaxes numpy.swapaxes Matft.mfarray.moveaxis numpy.moveaxis Matft.mfarray.sort numpy.sort Matft.mfarray.argsort numpy.argsort

- ファイル関係 saveが未完成です.

Matft Numpy Matft.mfarray.file.loadtxt numpy.loadtxt Matft.mfarray.file.genfromtxt numpy.genfromtxt

- 演算系

Matft Numpy Matft.mfarray.add numpy.add Matft.mfarray.sub numpy.sub Matft.mfarray.div numpy.div Matft.mfarray.mul numpy.multiply Matft.mfarray.inner numpy.inner Matft.mfarray.cross numpy.cross Matft.mfarray.equal numpy.equal Matft.mfarray.allEqual numpy.array_equal Matft.mfarray.neg numpy.negative

- 初等関数系

Matft Numpy Matft.mfarray.math.sin numpy.sin Matft.mfarray.math.asin numpy.asin Matft.mfarray.math.sinh numpy.sinh Matft.mfarray.math.asinh numpy.asinh Matft.mfarray.math.sin numpy.cos Matft.mfarray.math.acos numpy.acos Matft.mfarray.math.cosh numpy.cosh Matft.mfarray.math.acosh numpy.acosh Matft.mfarray.math.tan numpy.tan Matft.mfarray.math.atan numpy.atan Matft.mfarray.math.tanh numpy.tanh Matft.mfarray.math.atanh numpy.atanh 面倒なので,省略します...笑

ここを見てください

- 高階関数系

Matft Numpy Matft.mfarray.stats.mean numpy.mean Matft.mfarray.math.max numpy.max Matft.mfarray.math.argmax numpy.argmax Matft.mfarray.math.min numpy.min Matft.mfarray.math.argmin numpy.argmin Matft.mfarray.math.sum numpy.sum

- 線形代数系

Matft Numpy Matft.mfarray.linalg.solve numpy.linalg.solve Matft.mfarray.linalg.inv numpy.linalg.inv Matft.mfarray.linalg.det numpy.linalg.det Matft.mfarray.linalg.eigen numpy.linalg.eig Matft.mfarray.linalg.svd numpy.linalg.svd Matft.mfarray.linalg.polar_left scipy.linalg.polar Matft.mfarray.linalg.polar_right scipy.linalg.polar インストール

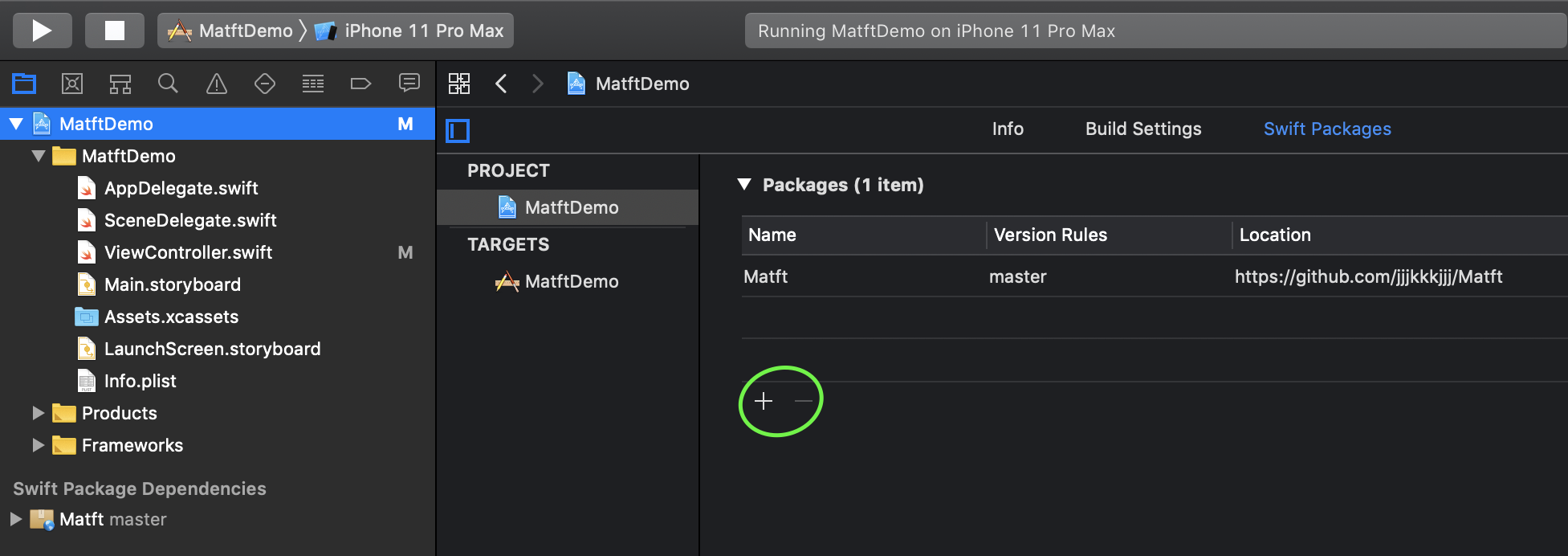

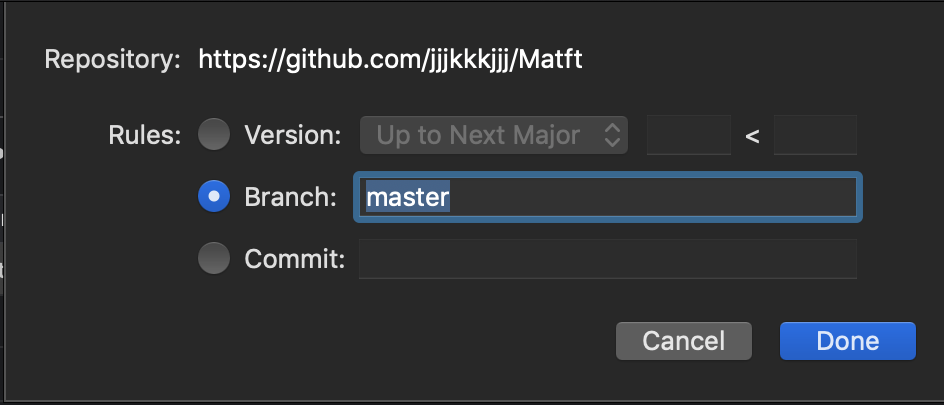

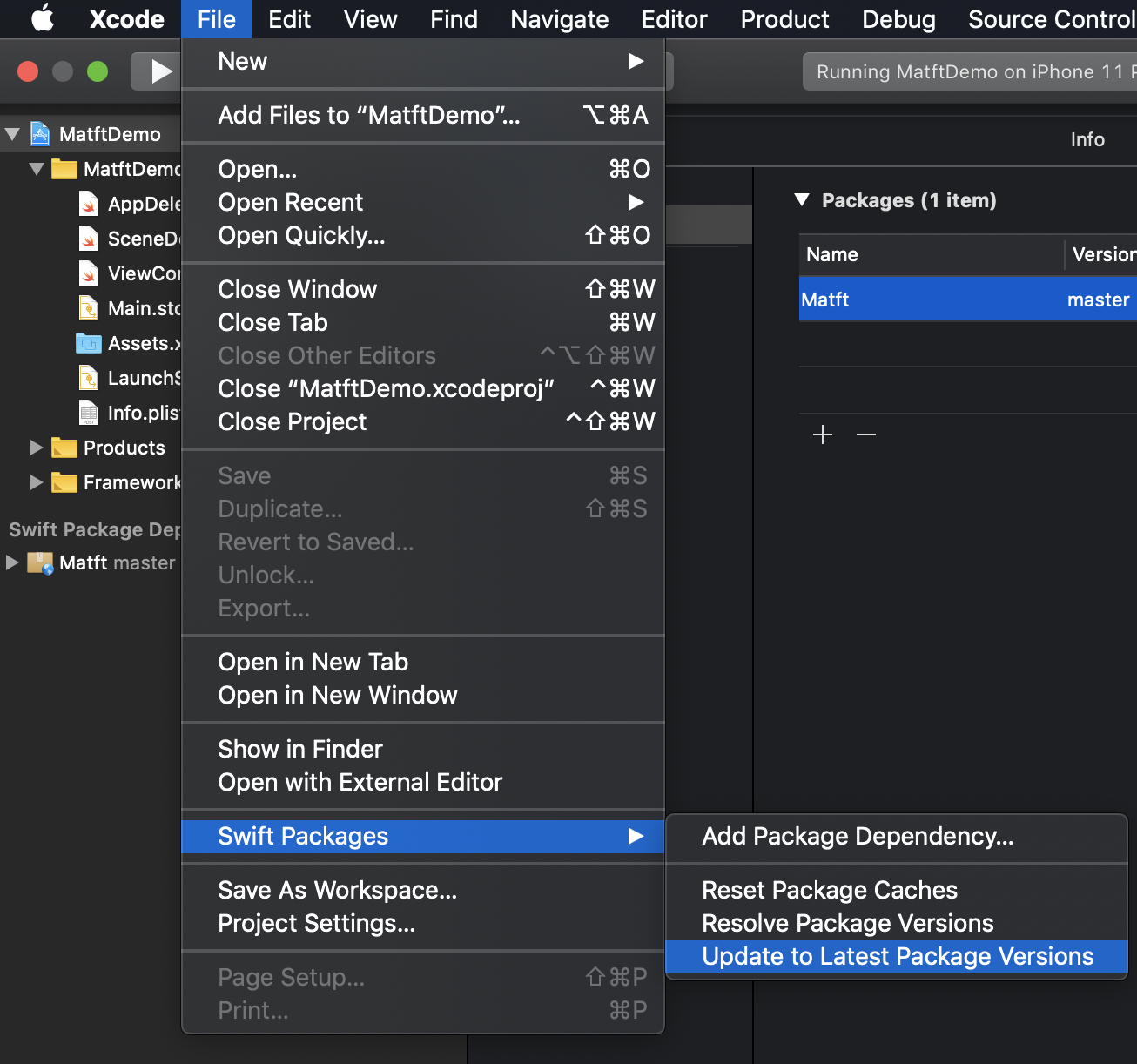

SwiftPMとCocoaPodに対応しました.

SwiftPM

- Import

- アップデート

CocoaPods

- Podfile作成 (すでにある場合は無視)

pod init

pod 'Matft'をPodfileに追記target 'your project' do pod 'Matft' end

- インストール

pod installPerformance

Accelerateに任せているので,計算は担保されていると言いましたが,足し算だけ速度を計算してみました.

時間があれば他の関数も調べます...

case Matft Numpy 1 1.14ms 962 µs 2 4.20ms 5.68 ms 3 4.17ms 3.92 ms

- Matft

func testPefAdd1() { do{ let a = Matft.mfarray.arange(start: 0, to: 10*10*10*10*10*10, by: 1, shape: [10,10,10,10,10,10]) let b = Matft.mfarray.arange(start: 0, to: -10*10*10*10*10*10, by: -1, shape: [10,10,10,10,10,10]) self.measure { let _ = a+b } /* '-[MatftTests.ArithmeticPefTests testPefAdd1]' measured [Time, seconds] average: 0.001, relative standard deviation: 23.418%, values: [0.001707, 0.001141, 0.000999, 0.000969, 0.001029, 0.000979, 0.001031, 0.000986, 0.000963, 0.001631] 1.14ms */ } } func testPefAdd2(){ do{ let a = Matft.mfarray.arange(start: 0, to: 10*10*10*10*10*10, by: 1, shape: [10,10,10,10,10,10]) let b = a.transpose(axes: [0,3,4,2,1,5]) let c = a.T self.measure { let _ = b+c } /* '-[MatftTests.ArithmeticPefTests testPefAdd2]' measured [Time, seconds] average: 0.004, relative standard deviation: 5.842%, values: [0.004680, 0.003993, 0.004159, 0.004564, 0.003955, 0.004200, 0.003998, 0.004317, 0.003919, 0.004248] 4.20ms */ } } func testPefAdd3(){ do{ let a = Matft.mfarray.arange(start: 0, to: 10*10*10*10*10*10, by: 1, shape: [10,10,10,10,10,10]) let b = a.transpose(axes: [1,2,3,4,5,0]) let c = a.T self.measure { let _ = b+c } /* '-[MatftTests.ArithmeticPefTests testPefAdd3]' measured [Time, seconds] average: 0.004, relative standard deviation: 16.815%, values: [0.004906, 0.003785, 0.003702, 0.005981, 0.004261, 0.003665, 0.004083, 0.003654, 0.003836, 0.003874] 4.17ms */ } }

- Numpy

In [1]: import numpy as np #import timeit a = np.arange(10**6).reshape((10,10,10,10,10,10)) b = np.arange(0, -10**6, -1).reshape((10,10,10,10,10,10)) #timeit.timeit("b+c", repeat=10, globals=globals()) %timeit -n 10 a+b 962 µs ± 273 µs per loop (mean ± std. dev. of 7 runs, 10 loops each) In [2]: a = np.arange(10**6).reshape((10,10,10,10,10,10)) b = a.transpose((0,3,4,2,1,5)) c = a.T #timeit.timeit("b+c", repeat=10, globals=globals()) %timeit -n 10 b+c 5.68 ms ± 1.45 ms per loop (mean ± std. dev. of 7 runs, 10 loops each) In [3]: a = np.arange(10**6).reshape((10,10,10,10,10,10)) b = a.transpose((1,2,3,4,5,0)) c = a.T #timeit.timeit("b+c", repeat=10, globals=globals()) %timeit -n 10 b+c 3.92 ms ± 897 µs per loop (mean ± std. dev. of 7 runs, 10 loops each)個人的に気に入っているところ

- 名前

- 複数型対応

- Numpyぽさ

最後に

気まぐれで作成しましたが,思ったよりいい感じのものができました.ただただ僕の検索力不足なだけで,より良いライブラリがあるかもしれませんが,是非試していただけると嬉しいです.(環境依存のチェックができていませんので,是非お願いします...)

とにもかくにもいい勉強になりました.ありがとうございました.参考

numpy

scipy

Accelerate

SwiftでNDArray書く(テストケースを参考にさせていただきました.)

- 投稿日:2020-05-15T23:51:32+09:00

SwiftでN次元行列演算ライブラリMatftを作ってみた

はじめに

初投稿です.

タイトルの通りなのですが,SwiftでN次元行列演算ライブラリMatftを作ってみました.(Mat rix演算をする・Swi ftで,の略でMatftです笑)事の発端は,会社の先輩の「Swiftで3行3列の逆行列を求めるコードを書いてほしい」という一言でした.

SwiftにはPythonのNumpyのようなN次元行列演算ライブラリがあるだろうと思ったのですが,調べると意外にもないんですよね...

公式のAccelerateは使い勝手悪そうだし,有名らしいsurgeも2次元まで?みたいでした.そんなこんなで,せっかくなので自作のN次元行列演算ライブラリを作ってみようと思いました.(3行3列の逆行列を求めるコードに対して,完全にオーバースペックですが笑)さらにそんなこんなで,Matftができました.そしてせっかくなので共有してみようということで,現在に至ります.

概要

基本的にはPythonのNumpyにならって作成したので,関数名や使い方はNumpyとほぼ同じです.

宣言

宣言は

ndarrayなるMfArrayで多次元配列を生成します.let a = MfArray([[[ -8, -7, -6, -5], [ -4, -3, -2, -1]], [[ 0, 1, 2, 3], [ 4, 5, 6, 7]]]) print(a) /* mfarray = [[[ -8.0, -7.0, -6.0, -5.0], [ -4.0, -3.0, -2.0, -1.0]], [[ 0.0, 1.0, 2.0, 3.0], [ 4.0, 5.0, 6.0, 7.0]]], type=Float, shape=[2, 2, 4] */型

いろいろな型に対応させたかったので,それなりの型を用意しました.

dtypeならぬMfTypeです.let a = MfArray([[[ -8, -7, -6, -5], [ -4, -3, -2, -1]], [[ 0, 1, 2, 3], [ 4, 5, 6, 7]]], mftype: .Float) print(a) /* mfarray = [[[ -8.0, -7.0, -6.0, -5.0], [ -4.0, -3.0, -2.0, -1.0]], [[ 0.0, 1.0, 2.0, 3.0], [ 4.0, 5.0, 6.0, 7.0]]], type=Float, shape=[2, 2, 4] */ let aa = MfArray([[[ -8, -7, -6, -5], [ -4, -3, -2, -1]], [[ 0, 1, 2, 3], [ 4, 5, 6, 7]]], mftype: .UInt) print(aa) /* mfarray = [[[ 4294967288, 4294967289, 4294967290, 4294967291], [ 4294967292, 4294967293, 4294967294, 4294967295]], [[ 0, 1, 2, 3], [ 4, 5, 6, 7]]], type=UInt, shape=[2, 2, 4] */ //Above output is same as numpy! /* >>> np.arange(-8, 8, dtype=np.uint32).reshape(2,2,4) array([[[4294967288, 4294967289, 4294967290, 4294967291], [4294967292, 4294967293, 4294967294, 4294967295]], [[ 0, 1, 2, 3], [ 4, 5, 6, 7]]], dtype=uint32)型一覧は以下のEnum型で定義しました.

※実を言うと,裏ではFloatかDoubleで保存しているので,UIntなんかは値が大きいとオーバーフローします.ただ,実用上は問題ないと思います.public enum MfType: Int{ case None // Unsupportted case Bool case UInt8 case UInt16 case UInt32 case UInt64 case UInt case Int8 case Int16 case Int32 case Int64 case Int case Float case Double case Object // Unsupported }Indexing

Numpyでいう

a[:, ::-1]のようなスライスも~で実装しました.

-1のような負のインデックスも実装しました.(これが一番苦労したかもしれません...)let a = Matft.mfarray.arange(start: 0, to: 27, by: 1, shape: [3,3,3]) print(a) /* mfarray = [[[ 0, 1, 2], [ 3, 4, 5], [ 6, 7, 8]], [[ 9, 10, 11], [ 12, 13, 14], [ 15, 16, 17]], [[ 18, 19, 20], [ 21, 22, 23], [ 24, 25, 26]]], type=Int, shape=[3, 3, 3] */ print(a[2,1,0]) // 21 print(a[1~3]) //same as a[1:3] for numpy /* mfarray = [[[ 9, 10, 11], [ 12, 13, 14], [ 15, 16, 17]], [[ 18, 19, 20], [ 21, 22, 23], [ 24, 25, 26]]], type=Int, shape=[2, 3, 3] */ print(a[-1~-3]) /* mfarray = [], type=Int, shape=[0, 3, 3] */ print(a[~~-1]) /* mfarray = [[[ 18, 19, 20], [ 21, 22, 23], [ 24, 25, 26]], [[ 9, 10, 11], [ 12, 13, 14], [ 15, 16, 17]], [[ 0, 1, 2], [ 3, 4, 5], [ 6, 7, 8]]], type=Int, shape=[3, 3, 3]*/その他関数一覧

ここからは,具体的な関数一覧です.主な計算はAccelerateに任せているので,計算時間はある程度担保されていると思います.

- 生成系

Matft Numpy Matft.mfarray.shallowcopy numpy.copy Matft.mfarray.deepcopy copy.deepcopy Matft.mfarray.nums numpy.ones * N Matft.mfarray.arange numpy.arange Matft.mfarray.eye numpy.eye Matft.mfarray.diag numpy.diag Matft.mfarray.vstack numpy.vstack Matft.mfarray.hstack numpy.hstack Matft.mfarray.concatenate numpy.concatenate

- 変換系

Matft Numpy Matft.mfarray.astype numpy.astype Matft.mfarray.transpose numpy.transpose Matft.mfarray.expand_dims numpy.expand_dims Matft.mfarray.squeeze numpy.squeeze Matft.mfarray.broadcast_to numpy.broadcast_to Matft.mfarray.conv_order numpy.ascontiguousarray Matft.mfarray.flatten numpy.flatten Matft.mfarray.flip numpy.flip Matft.mfarray.swapaxes numpy.swapaxes Matft.mfarray.moveaxis numpy.moveaxis Matft.mfarray.sort numpy.sort Matft.mfarray.argsort numpy.argsort

- ファイル関係 saveが未完成です.

Matft Numpy Matft.mfarray.file.loadtxt numpy.loadtxt Matft.mfarray.file.genfromtxt numpy.genfromtxt

- 演算系

Matft Numpy Matft.mfarray.add numpy.add Matft.mfarray.sub numpy.sub Matft.mfarray.div numpy.div Matft.mfarray.mul numpy.multiply Matft.mfarray.inner numpy.inner Matft.mfarray.cross numpy.cross Matft.mfarray.equal numpy.equal Matft.mfarray.allEqual numpy.array_equal Matft.mfarray.neg numpy.negative

- 初等関数系

Matft Numpy Matft.mfarray.math.sin numpy.sin Matft.mfarray.math.asin numpy.asin Matft.mfarray.math.sinh numpy.sinh Matft.mfarray.math.asinh numpy.asinh Matft.mfarray.math.sin numpy.cos Matft.mfarray.math.acos numpy.acos Matft.mfarray.math.cosh numpy.cosh Matft.mfarray.math.acosh numpy.acosh Matft.mfarray.math.tan numpy.tan Matft.mfarray.math.atan numpy.atan Matft.mfarray.math.tanh numpy.tanh Matft.mfarray.math.atanh numpy.atanh 面倒なので,省略します...笑

ここを見てください

- 高階関数系

Matft Numpy Matft.mfarray.stats.mean numpy.mean Matft.mfarray.stats.max numpy.max Matft.mfarray.stats.argmax numpy.argmax Matft.mfarray.stats.min numpy.min Matft.mfarray.stats.argmin numpy.argmin Matft.mfarray.stats.sum numpy.sum

- 線形代数系

Matft Numpy Matft.mfarray.linalg.solve numpy.linalg.solve Matft.mfarray.linalg.inv numpy.linalg.inv Matft.mfarray.linalg.det numpy.linalg.det Matft.mfarray.linalg.eigen numpy.linalg.eig Matft.mfarray.linalg.svd numpy.linalg.svd Matft.mfarray.linalg.polar_left scipy.linalg.polar Matft.mfarray.linalg.polar_right scipy.linalg.polar インストール

SwiftPMとCocoaPodに対応しました.

SwiftPM

- Import

- アップデート

CocoaPods

- Podfile作成 (すでにある場合は無視)

pod init

pod 'Matft'をPodfileに追記target 'your project' do pod 'Matft' end

- インストール

pod installPerformance

Accelerateに任せているので,計算は担保されていると言いましたが,足し算だけ速度を計算してみました.

時間があれば他の関数も調べます...

case Matft Numpy 1 1.14ms 962 µs 2 4.20ms 5.68 ms 3 4.17ms 3.92 ms

- Matft

func testPefAdd1() { do{ let a = Matft.mfarray.arange(start: 0, to: 10*10*10*10*10*10, by: 1, shape: [10,10,10,10,10,10]) let b = Matft.mfarray.arange(start: 0, to: -10*10*10*10*10*10, by: -1, shape: [10,10,10,10,10,10]) self.measure { let _ = a+b } /* '-[MatftTests.ArithmeticPefTests testPefAdd1]' measured [Time, seconds] average: 0.001, relative standard deviation: 23.418%, values: [0.001707, 0.001141, 0.000999, 0.000969, 0.001029, 0.000979, 0.001031, 0.000986, 0.000963, 0.001631] 1.14ms */ } } func testPefAdd2(){ do{ let a = Matft.mfarray.arange(start: 0, to: 10*10*10*10*10*10, by: 1, shape: [10,10,10,10,10,10]) let b = a.transpose(axes: [0,3,4,2,1,5]) let c = a.T self.measure { let _ = b+c } /* '-[MatftTests.ArithmeticPefTests testPefAdd2]' measured [Time, seconds] average: 0.004, relative standard deviation: 5.842%, values: [0.004680, 0.003993, 0.004159, 0.004564, 0.003955, 0.004200, 0.003998, 0.004317, 0.003919, 0.004248] 4.20ms */ } } func testPefAdd3(){ do{ let a = Matft.mfarray.arange(start: 0, to: 10*10*10*10*10*10, by: 1, shape: [10,10,10,10,10,10]) let b = a.transpose(axes: [1,2,3,4,5,0]) let c = a.T self.measure { let _ = b+c } /* '-[MatftTests.ArithmeticPefTests testPefAdd3]' measured [Time, seconds] average: 0.004, relative standard deviation: 16.815%, values: [0.004906, 0.003785, 0.003702, 0.005981, 0.004261, 0.003665, 0.004083, 0.003654, 0.003836, 0.003874] 4.17ms */ } }

- Numpy

In [1]: import numpy as np #import timeit a = np.arange(10**6).reshape((10,10,10,10,10,10)) b = np.arange(0, -10**6, -1).reshape((10,10,10,10,10,10)) #timeit.timeit("b+c", repeat=10, globals=globals()) %timeit -n 10 a+b 962 µs ± 273 µs per loop (mean ± std. dev. of 7 runs, 10 loops each) In [2]: a = np.arange(10**6).reshape((10,10,10,10,10,10)) b = a.transpose((0,3,4,2,1,5)) c = a.T #timeit.timeit("b+c", repeat=10, globals=globals()) %timeit -n 10 b+c 5.68 ms ± 1.45 ms per loop (mean ± std. dev. of 7 runs, 10 loops each) In [3]: a = np.arange(10**6).reshape((10,10,10,10,10,10)) b = a.transpose((1,2,3,4,5,0)) c = a.T #timeit.timeit("b+c", repeat=10, globals=globals()) %timeit -n 10 b+c 3.92 ms ± 897 µs per loop (mean ± std. dev. of 7 runs, 10 loops each)個人的に気に入っているところ

- 名前

- 複数型対応

- Numpyぽさ

最後に

気まぐれで作成しましたが,思ったよりいい感じのものができました.ただただ僕の検索力不足なだけで,より良いライブラリがあるかもしれませんが,是非試していただけると嬉しいです.(環境依存のチェックができていませんので,是非お願いします...)

とにもかくにもいい勉強になりました.ありがとうございました.参考

numpy

scipy

Accelerate

SwiftでNDArray書く(テストケースを参考にさせていただきました.)

- 投稿日:2020-05-15T23:05:48+09:00

ゼロから始めるLeetCode Day26「94. Binary Tree Inorder Traversal」

概要

海外ではエンジニアの面接においてコーディングテストというものが行われるらしく、多くの場合、特定の関数やクラスをお題に沿って実装するという物がメインである。

その対策としてLeetCodeなるサイトで対策を行うようだ。

早い話が本場でも行われているようなコーディングテストに耐えうるようなアルゴリズム力を鍛えるサイト。

せっかくだし人並みのアルゴリズム力くらいは持っておいた方がいいだろうということで不定期に問題を解いてその時に考えたやり方をメモ的に書いていこうかと思います。

前回

ゼロから始めるLeetCode Day25「70. Climbing Stairs」基本的にeasyのacceptanceが高い順から解いていこうかと思います。

Twitterやってます。

問題

543. Diameter of Binary Tree

難易度はeasy。

Top 100 Liked Questionsからの抜粋です。二分木が与えられるので、その木の直径を返します。

なお、ここでの直径とは各ノード間の中で最も長い距離を行き来するような通路のことを指します。Example: Example: Given a binary tree 1 / \ 2 3 / \ 4 5 Return 3, which is the length of the path [4,2,1,3] or [5,2,1,3]. Note: The length of path between two nodes is represented by the number of edges between them.この場合だと4から3までいく場合と5から3までいくものの二つが最長であり、間にある枝の数が3なので3を返します。

解法

深さ優先探索でときました。

# Definition for a binary tree node. # class TreeNode: # def __init__(self, val=0, left=None, right=None): # self.val = val # self.left = left # self.right = right class Solution: def diameterOfBinaryTree(self, root: TreeNode) -> int: self.ans = 0 def dfs(node): if not node: return 0 right = dfs(node.right) left = dfs(node.left) self.ans = max(self.ans,left+right) return max(left,right) + 1 dfs(root) return self.ans # Runtime: 44 ms, faster than 72.73% of Python3 online submissions for Diameter of Binary Tree. # Memory Usage: 15.9 MB, less than 51.72% of Python3 online submissions for Diameter of Binary Tree.基本的な流れは一般的な深さ優先探索のそれと一緒です。ただ、今回は長さを調べる必要があるので、そのための変数

ansを用意し、計算を付け加えました。割と過去の木の問題でも深さ優先探索ばかり書いているのでそろそろ幅優先探索とかも勉強しなきゃなぁと思います。

今日はもう遅いのでこれでお終いです、お疲れ様でした。良さげな解答が他にあれば追記します。

- 投稿日:2020-05-15T22:43:28+09:00

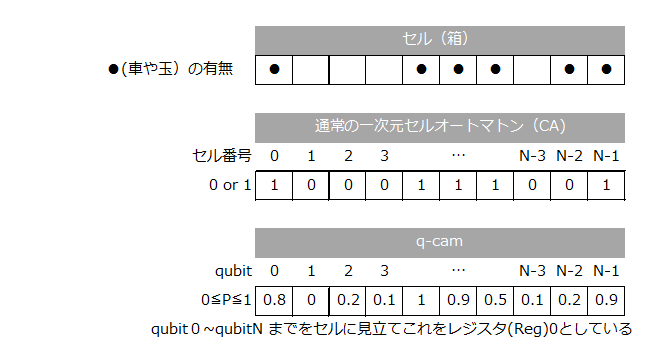

【数式なしの量子コンピュータ】 新視点セルオートマトンとグローバー 2回目 1、0ではない重ね合わせでの初期状態

連載記事の2回目 1,0ではない重ね合わせでの初期状態

いきなりこの回を読むと意味不明かもしれない。その場合は、1回目 を読んで頂きたい。本連載記事の目的と概要を投稿している。今回から具体的なBlueqatでの量子コンピュータの記事となる。ただ本題となるセルオートマトンの量子アルゴリズムやその時間発展は4回目以降の予定。今回の目玉は1,0ではない確率初期状態のセッティング方法とBlueqatで確率だの状態ベクトルだのをどう料理するのかである。まず、その前提としてq-camの構造とモジュールを紹介する。2-1. q-camの構造とモジュール

Githubに公開したq-camsの中にあるプログラムとモジュールの表を示す。尚、以降、q-camsと表記した部分は、Githubのリポジトリ―にリンクしている。尚、御覧のとおりファイル名の拡張子はpy、つまり言語はpythonである。

ファイル名 内容 説明のある回 qcam.py q-cam専用の、初期確率セット

ベクトルと確率の抽出、出力、プロットなどのモジュール2回目 qmcn.py Blueqatで汎用的に使用できるモジュール

マルチ制御NOTゲート CCCX~CCCCCCX

フレドキンゲート3回目 probshot.py セットした確率を観測でみる 2回目 probvect.py セットした確率を状態ベクトルでみる 2回目 q-cam30r.py ルール30 セルオートマトン 4回目 q-cam60r.py ルール60 セルオートマトン 4回目 q-cam90r.py ルール90 セルオートマトン 4回目 q-cam102r.py ルール102 セルオートマトン 4回目 q-cam110r.py ルール110 セルオートマトン 4回目 q-cam184r.py ルール184 セルオートマトン ルール 5回目 q-cam184i.py ルール184 セルオートマトン 虚数版 5回目 q-cambbr.py ソリトン(箱玉系)セルオートマトン 6回目 q-camgr.py グローバーアルゴリズム 7回目 q-camの構造と言っているのは上の表のq-cam30r.py以下のプログラムにおける共通構造のことである。今回紹介する「1,0ではない確率初期状態のセッティング方法」は、qcam.pyのモジュール内の関数であり、またBlueqatで確率だの状態ベクトルだのをどう料理するのかは、probshot.pyとprobvect.pyと言うプログラムを用いての説明となる。モジュールqcamとqmcnはプログラムと同じフォルダにダウンロードして使用することが前提。各、プログラムはコンソールから動かす。さて、q-camの構造は単純で以下の通りである。

①モジュールの読み込み部

②定数セット部

③Blueqatで記述した量子プログラム部(Q-process)

④メインの制御部

⑤終了部分(プロットなど)順に実際のコード例で説明しよう。

①モジュールの読み込み部example1.pyfrom blueqat import Circuit import numpy as np import qcam import qmcn as q一行目はBlueqatを使う場合、必要な読み込みで詳しくはこちらを参照。https://blueqat.readthedocs.io/ja/latest/

二行目は、numpyを使用するため。3行目のqcamは、q-camプログラムで必須のモジュール。

import qcam as qcなどとし略称でモジュールを使用できるようにしても、勿論OK。ラストの行にあるqmcnは、マルチ制御NOTゲートを使わない限りは不要で、q-camsのプログラム群の中ではグローバーアルゴリズムとソリントセルオートマトン以外では使用しない。②定数セット部

example2.pyN=10 # number of cells R=2 # number of registers # initial probability distribution initial_a=np.array([0.8,0,0.2,0.1,1,0.9,0.5,0.1,0.2,0.9],dtype='float')Nはセルオートマトンでのセル数(下図参照)、Rはレジスタ数で、この積NRが全量子ビット数となる。セルに見立てたN個の量子ビット(0~N-1)もレジスタに含まれ、これをレジスタ0とする。セル数Nはユーザーが好きに書き変えられるが、レジスタ数はセルオートマトンのアルゴリズムに依存する。詳しくは4回目に説明する。Blueqatの場合、量子ビット数の上限は32bitなので、NR≦32だが、24ぐらいを超えると計算時間が長くなる。また、配列initial_a は、まさに今回の「0,1ではない確率の集合」を現しており、左から順に、セルに割り当てらる。従ってこの配列の要素数は必ず、上記のセル数と一致しなければならない。下図参照。これらの確率を実際の量子ビットにセットするのが、1,0ではない確率初期状態のセッティング方法であって2-2で説明する。

上のコード内では省略したが定数セット部はさらにつづが、主として各レジスタのスタート量子ビット番号とラスト量子ビット番号の割り当てである。

③Blueqatで記述した量子プログラム部(Q-process)

この部分は、まさにBlueqatで量子アルゴリズムを記述する部分であり、内容は4回目に説明する。最も簡単な例として、ルール102の場合の量子プログラム部を示す。example3.pydef qproc(): for i in range(N): c.cx[1+i, i] return④メインの制御部

メインの制御部の代表的例

example4.pypstep=0 ret='y' while ret=='y': pstep+=1 c=Circuit(N) pinitial_a=probability_a if pstep==1: pinitial_a=initial_a qcam.propinit(N,c,pinitial_a) qproc() master_a=np.array(c.run()) num,vector_a,prob_a=qcam.qvextract(N,R,1,master_a) stdev,probability_a=qcam.qcalcd(N, num,vector_a,prob_a) qcam.qcresultout(N, pstep, num,pinitial_a,vector_a,prob_a,stdev,probability_a) stepdist_a[pstep,0:N]=probability_a[0:N] stdev_a[pstep]=stdev ret=input(' NEXT(Y/N)?')

pstepは時間発展(1回目 参照)のカウンタで初期を0としている。配列pinitial_aはその時間ステップのセルオートマトンの遷移前の初期状態で、時刻1、つまりpstep=1のときは、initial_aそのものである。まずはじめにpinitial_a配列の確率を量子ビットにセットする。それが2-2で説明するqcamモジュール内のpropinit関数である。これでセル番号0~N-1に見立てたreg0の量子ビット番号0~N-1に確率(確率振幅)がセットされる。セット後、qproc()で遷移のためのBlueqatの量子プロセスとなる。実際の実行はBlueqatの

c.run()である。このBlueqatの命令は2-3で説明する状態ベクトルを見る方法である。状態ベクトルといいつつ実はBlueqatではベクトルそのものがこれで分かるわけではなく、その状態ベクトルの確率振幅がベクトルの数だけ、複素数表記の一次元リストの形で戻ってくる。それをmaster_aという一次元の配列に取り込み、これから状態ベクトルだの、確率だのを抽出し、計算をする。ある時刻ステップ(pstep)のセルの確率の結果は、次の時刻ステップ(pstep+1)の初期状態となるように代入している。

stepdist_a[pstep,0:N]=probability_a[0:N]コンソール上で NEXT(Y/N)?と入力を促し、yと入力した場合は、次の時間ステップに進む。この繰り返しで、1ステップづつ時間発展をさせていく。y以外を入力した場合は以下の⑤に続く。⑤終了部分(プロットなど)

時間発展の結果をまとめて表示する関数qcam.qcfinalとセルオートマトンの時間発展を視覚的に表現するための関数qcam.qcamplotを実行し終了となる。尚、これらの出力内容に関しては4回目で詳述する。2-2. 1,0ではない確率的初期状態(ry 又は rx 又は u3 ゲートで作る)

さて、いよいよ、セルに見立てた量子ビットに「0,1ではない確率の集合」をセットする方法である。ある量子ビット、ここではi番目の量子ビットを

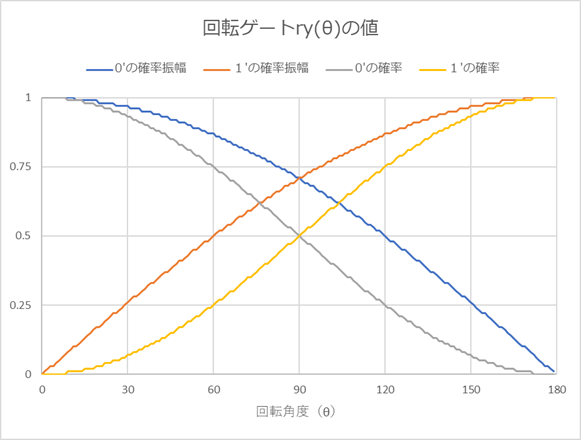

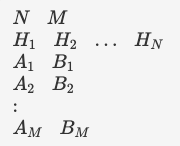

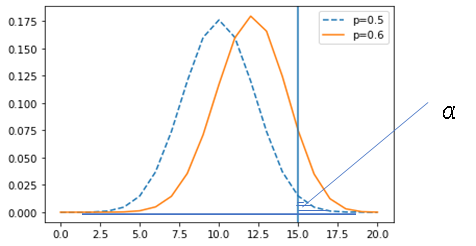

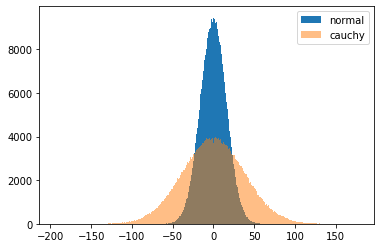

qubit[i]と表現しよう。またqubit[i]の状態を示すのをqubit[i]⇒と表現しよう。確率ゼロをセットするのは簡単で、BlueqatのCircuitオブジェクトを作成後、何もしなければゼロ状態である。つまりqubit[i]⇒0である。状態1をセットするのも簡単でBlueqatのXゲート(反転あるいはフリップゲートとも称する)を使えばqubit[i]⇒1となる。コードで記せば、x[qubit[i]]である。では、次に0と1がちょうど半々で重ねあった状態、つまり確率0.5、qubit[i]⇒0.5は? これも簡単でアダマールゲートを使えば良い。コードで記せば、h[qubit[i]]である。では、qubit[i]⇒0.33とするには?今、y軸での回転ゲートryで0度から180度まで1度おきに回転させた時の一つのqubitの状態1と状態0のもっている割合、つまり重ね合わせの混合割合の平方根(=確率振幅)と、それを二乗した値=混合割合=確率を見てみよう。(グラフ)

参考コード

example5.pyfrom blueqat import Circuit import numpy as np for j in range(180): c=Circuit(1) theta=j*np.pi/180 c.ry(theta)[0] result=c.run() q0=round(result[0].real,2) q1=round(result[1].real,2) q2=round(result[0].real**2,2) q3=round(result[1].real**2,2) print(j,'{0:>6} {1:>6} {2:>6} {3:>6}'.format(q0,q1,q2,q3))

セルに見立てたひとつの量子ビットにセットするのは、車や玉がそのセルにどの程度存在しているのか、つまり「1(車あるいは玉などが有)」の確率である。(100%そこに車が存在していれば1、全くいなければ0%だが、33%そこに車がいるとは?)グラフを見てわかる通りryの確率振幅は単なるsin関数(実際には$\sinθ/2$)である。その確率(確率振幅の二乗)は $\ P_1=sin^2θ/2$ である。従って、ある確率Pが与えられた場合、この式から角度θが逆算できる。数式が出て申し訳ないが、$\ θ=2arcsin ( \sqrt{P_1}\ ) $、このθをryゲートの回転角として量子ビットに適用すれば、その量子ビットに所望の確率(確率振幅)をセットすることができる。確率0.5、つまりアダマールの場合、θ=π/2、つまり90度となる。尚、「1」はπ(180度)、「0」はゼロ度である。

qcamモジュールのpropinit関数に引数として、セル数N、Blueqatのサーキットオブジェクトc、セルに見立てた量子ビットの各々の確率の配列を渡すと、ryゲートを用いて確率をセットできる。

example6.pydef propinit(NN, c, ppinit_a): for i in range(NN): theta=2* np.arcsin(np.sqrt(ppinit_a[i])) # Correlation between Probability and Rotation Angle c.ry(theta)[i] # You can change from ry to rx. returnまた、y軸での回転ゲートに代えてx軸での回転ゲートrxも全く同様に使用できる。(ryをrx書き換えるだけでOK) rxに置き換えた場合、「0」はryの場合と全く同じだが、「1」には実数での確率振幅はなくなり、虚数の確率振幅を持つようになる。だが、二乗すれば虚数(複素数)でも確率となり同じである。それは兎に角「1」の確率 $P_1$は、「0」の余事象であるので、$P_1=1-P_0$。また、$P_1$ は $P_1=cos^2θ/2$ であるため、$P_1=1-cos^2θ/2=sin^2θ/2$ となる。故に、これはryゲートの場合と全く同様となる。

u3ゲートで確率+αを与えてみた

一つの量子ビットに対して、重ね合わせ的には「1」とその余事象である「0」しかなく、確率としての「1」、「0」を捉えているが、確率振幅であれば、もう一つ情報を追加できると考えた。「1」の実数と虚数、「0」の実数部である。「0」の虚数部は常にゼロである。確率以外の情報を増やすと何が生じるのか知りたくて考えたのだが... 当然、セルに見立てた量子ビットには単なる確率ではなくて、複素数をセットしなくてはならない。「1」の確率を $P_A$、 $P_B$の二つにわけ、前者を実数、後者を虚数に振り分けることとして、残りは余事象である、$P_0$とする。今、$P_0=0.3$とした場合、$P_A+P_B=0.7$。さらに$P_A=0.5$、$P_B=0.2$ とする場合、initial_aの配列要素としてnumpyのcomplex型を用いて、0.5+0.2j と記せばよい。これを量子ビットにセットするには、ユニバーサルゲートであるu3を使えばできる。u3のθ、φ、λをryやrxの時と同様に考えて以下の式を得る。

* $θ=2arccos\sqrt P_B$

* $φ=arccos\sqrt{P_A/(1-P_0)}$

* $λ=arcsin\sqrt{P_B/(1-P_0)}$

以下はqcam.impropinitのコードで、q-cam184iのみに使用される。

example7.pydef rotangle(probi): Areal=probi.real Bimag=probi.imag Zero=1-Areal-Bimag if Zero==1: phi=0 lam=0 else: phi=np.arccos(np.sqrt(Areal/(1-Zero))) lam=np.arcsin(np.sqrt(Bimag/(1-Zero))) theta=2*np.arccos(np.sqrt(Zero)) return theta,phi,lam def impropinit(NN, c, ppinit_a): for i in range(NN): ptheta,pphi,plam=rotangle(ppinit_a[i]) c.u3(ptheta,pphi,plam)[i] return2-3. Blueqatの状態ベクトル表示からのベクトルと確率の抽出

Blueqatには、量子コンピューティングの結果をみる手段として、観測と状態ベクトルの「覗き見」が用意されている。観測に関しては後述。状態ベクトルののぞき見命令は

c.run()である。状態ベクトルを見る方法ではあるが、ベクトルそのものがこれで分かるわけではなく、その状態ベクトルの確率振幅が状態ベクトルの数だけ、複素数表記の一次元リストの形で戻ってくる。状態ベクトルとその数って? 例えば、全部で4量子ビットなら、状態ベクトルは、0000、1000、0100、1100、0010、1010、0110、1110、0001、1001、0101、1101、0011、1011、0111、1111の16個である。状態ベクトルの数は $2^4=16$ 、つまり、全部でn量子ビットならば $2^n$ 個となる。q-camの場合の全量子ビット数は大概20を超えるので、$2^{20}=1,048,576$ つまり百万個以上である。Blueqatで確率振幅が状態ベクトルの数だけ複素数表記の一次元リストの形で戻ってくるとは、要は百万個以上の複素数の要素を持ったリストが答えとなっているということである。だが、幸いq-cmaの場合、その大多数の状態ベクトルは確率振幅ゼロ、つまり意味なしである。だから、確率振幅なり、その二乗である確率(その状態ベクトルが出現する確率)がゼロより大きいものだけを抽出すればよい。それは、しらみつぶしに

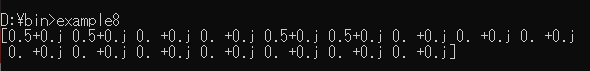

c.run()の戻り値リストの先頭から順に値がゼロより大のものを抽出するということである。しかし、複素数の値そのものは確率振幅であって、それがどの状態ベクトルの値なのかが分からないのでは。・・・んなわけはないはず。上述した4量子ビット時の状態ベクトルを左が小さい桁で表した二進数表記と考えると左から順に大きくなっていく。10進数に直せば、0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15である。Blueqatの状態ベクトルの覗き見の結果は、まさにこの順で出力されている。例えば、全4量子ビットで、0番目と2番目の量子ビットにアダマールゲートを適用した時の

c.run()の結果を見てみよう。example8.pyfrom blueqat import Circuit c=Circuit(4) c.h[0,2] print(c.run())上のコードをコンソールで実行した結果が以下である。

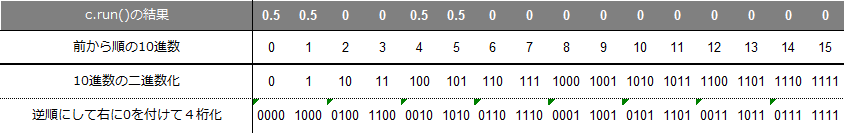

このc.run()の結果に、前から順番に10進数を付けた後、それを二進数に変換し、さらに、その二進数を逆順にして、4桁に満たない場合は右に4桁になるように0をつける。(下表参照)これでできた二進数こそ、複素数のリストに対応した状態ベクトルである。

リストの先頭から1づつ増加するカウンタでループさせた場合、このカウンタこそが、確率振幅に対応した状態ベクトルである。前述したが、q-camでは状態ベクトルが百万以上になるため、確率振幅なり、その二乗である確率(その状態ベクトルが出現する確率)がゼロより大きいものだけを抽出し、その時のカウンタのみから状態ベクトルを求めれば良く、そのことを抽出と称している。その抽出関数がqcamモジュールの

qcam.qvextractである。pythonで10進数のカウンタをbinで2進数化した時、先頭に二進数であることを明示する'0b'が付いてくる。この'0b'付き二進数をリスト化してdelで'0b'をカットする。さらに、qcamの場合、確率として必要なのは全量子ビット(NR個)の内、ゼロレジスタ(初めのN個)の部分のみであるため、全量子ビットのベクトルから一番末尾に来るN個分をスライスする。example9.pydef qvextract(NN,RN,RW,extract_a): reg0_a=np.array([['0']*NN]*2**NN) # [result-number,cell-number] tempo_list=['0']*NN eprobv_a=np.array([0]*2**NN,dtype='complex') ereprov_a=np.array([0]*2**NN,dtype='float') nm=0 for i in range(len(extract_a)): if abs(extract_a[i])>0.0001: # Decimal 'i' is the very vector! tempo1_list=list(bin(i)) # vector extraction but reversed. (Decimal to Binary) del tempo1_list[0:2] # Delete '0','b' in tempo list tempo1_list[0:0]=['0']*(NN*RN-len(tempo1_list)) # Zero-fill to adjust digits reg0_a[nm,0:NN]=tempo1_list[(1-RW)*NN-1:-RW*NN-1:-1] # slice and reverse eprobv_a[nm]=extract_a[i] # Probability amplitude nm+=1 for i in range(nm): ereprov_a[i]=eprobv_a[i].real*eprobv_a[i].real+eprobv_a[i].imag*eprobv_a[i].imag return nm,reg0_a,ereprov_a2-4. Blueqatのベクトルと観測

2-3.までで

c.run()の結果から状態ベクトルとそれに対応したそのベクトルが出現する確率までが抽出できた。だが、知りたいのは量子ビットごとの「1(車あるいは玉などが有)」の確率である。2-3.での例では、0番目と2番目の量子ビットにアダマールゲートを適用した。ということは、2-2.で説明した「0と1がちょうど半々で重ねあった状態、つまり確率0.5」を0番目と2番目の量子ビットにセットしたことを意味している。つまり、qubit[0]⇒0.5 qubit[2]⇒0.5となっている筈である。2-3.の結果の中から

確率振幅>0のものだけを抽出すると、10進数で言う0,1,4,5である。これらの状態ベクトルは下表に示した通りである。今、確率①(確率振幅の二乗)とベクトルの各要素②との積を③とする。各ベクトルごとのこの③の値を、量子ビット番号ごとに和をとると、表に示した通り、0番目と2番目の量子ビットが0.5となる。つまり、qubit[0]⇒0.5 qubit[2]⇒0.5であり、これでやっとc.run()の結果から知りたいことを知ることができた。q-camで、この処理を行う関数が以下のqcam.qcalcdである。二次元配列

csum_aに、j番目のベクトルのi番目の量子ビットの値③を格納する。こうすることによりループを回さずにnumpyのsum関数np.sum(csum_a,axis=0)を用いて、量子ビットごとの確率を求め、それを一次元配列cproreal_aに格納している。こうすることにより、c.run()と言うBlueqatの「覗き見」命令から量子ビットごとの「1(車あるいは玉などが有)」の正確な確率を得ることができる。example10.pydef qcalcd(NN, cnum, cvect_a, cprobare_a): cproreal_a=np.array([0]*NN,dtype = 'float') csum_a=np.array([[0]*NN]*cnum,dtype = 'float') for j in range(cnum): for i in range(NN): csum_a[j,i]=float(cvect_a[j,i])*cprobare_a[j] cproreal_a=np.sum(csum_a,axis=0) cstd=np.std(cproreal_a) return cstd,cproreal_aだが、リアルの量子コンピュータでは「覗き見」などできないはずである。代わりに「観測」を行う。この「観測」を行ってしまうと、残念なことに、ある量子ビットが1と0を同時にある割合で重ね合わされていたとしても、その割合を直接的に知ることはできず、「観測」をしたとたんに、結果は1か0のどちらかになってしまう。この量子力学上の残念な性質を波束の収縮と言う。でも心配することはない。同じ試行(この場合は量子コンピューティング)を何度も繰り返すと、1状態が出る回数と0状態が出る回数の割合を知ることができる。例えば、100回繰り返して、1状態が60回、0状態が40回という結果であれば、大体、状態1の確率が0.6であると知ることができる。

Blueqatではこのような観測と試行の繰り替えしとして、

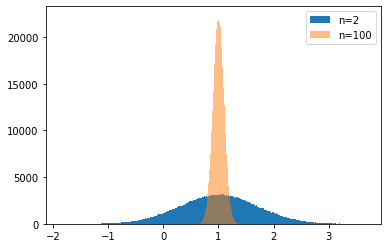

c.m[:].run(shots=number)(numberは試行回数)が準備されている。下のプログラムprobshot.pyではセル数を8とし、試行回数を1000回としている。0~N-1量子ビットの初期セット確率は[0.4,0,1,0.5,1,0,0,0.2]とした。これらは自由に書き換えて実行することができる。量子ビットにこの確率セットした後、何の量子コンピューティングもせずに観測のみ実行する。何の量子コンピューティングもせずに観測しているので、当然セットした確率と同じ確率が結果となるはずであるが・・・尚、

c.m[:].run(shots=number)の結果はdict(辞書)型で、キーは状態ベクトル、値はその状態ベクトルが出現した回数である。従って、この出現回数を試行回数で割れば確率となる。

コード

probshot.pyfrom blueqat import Circuit import numpy as np import qcam # -------- Setting ------------------------------------------------------------------ N=8 # number of qubits :You can change. nrun=1000 # number of runs :You can change. initial_a=np.array([0.4,0,1,0.5,1,0,0,0.2],dtype='float') # initial probability distribution :You can change. vector_a=np.array([[0]*N]*(2^N),dtype='int') csum_a=np.array([[0]*N]*(2^N),dtype='float') final_a=np.array([0]*N,dtype='float') prob_a=np.array([0]*(2^N),dtype='float') #---------- Main Body ---------------------------------------------------------------- ret='y' while ret=='y': c=Circuit(N) qcam.propinit(N,c,initial_a) ans=c.m[:].run(shots=nrun) num=len(ans) kk=list(ans.keys()) vv=list(ans.values()) for i in range(num): vector_a[i,0:N]=list(kk[i]) # Result Vectors prob_a[i]=vv[i]/nrun stdev,final_a=qcam.qcalcd(N,num,vector_a, prob_a) qcam.qcresultout(N, 0, num, initial_a, vector_a, prob_a,stdev, final_a) ret=input(' NEXT(Y/N)?')

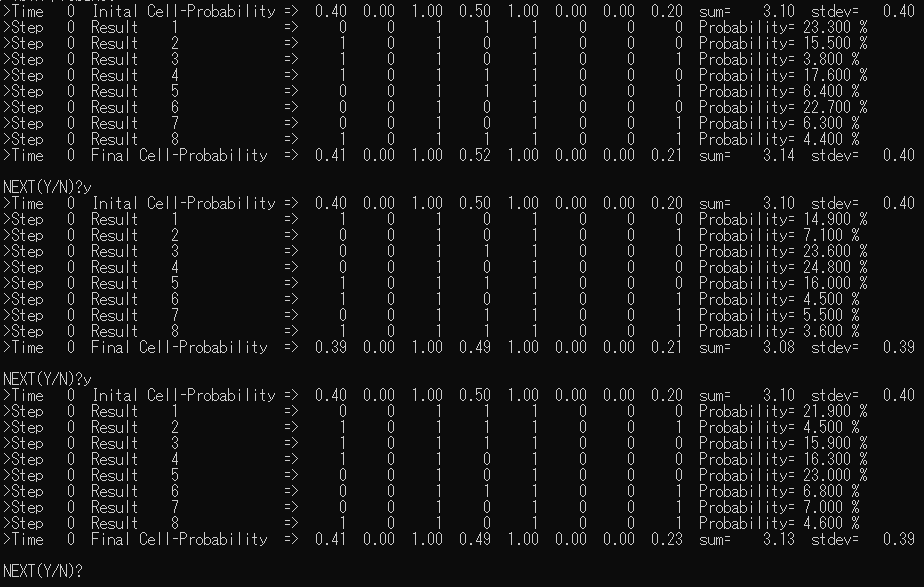

以下、コンソールでの実行結果である。

NEXT(Y/N)?でyを入力すると、q-camのような時間発展ではなく、ただ単に同じことを繰り返す。

この出力結果の見方を簡単に説明する。TimeとStepはq-camの用の時間発展を示しているのでここでは無視。sumは各量子ビットの確率の単純な和。またstdevはその分散だが、やはりここでは関係ない。Initial Cell-Probability は初期にセットした確率。Result 1 からは確率が0より大きい結果となった状態ベクトルとそのベクトルの確率(=出現回数/試行回数の%)をProbabilityとして出力している。最後の Final Cell-Probability は状態ベクトルとその確率から計算した、各量子ビットごとの確率である。

さて、当然、何も処理をしていないのだから Initial Cell-Probability と Final Cell-Probability は等しくなければならないが、どうであろう。1000回の試行を三度繰り返しているが、小数点第2位では結構な誤差が出てしまっている上、毎回少しずつ異なる。観測とは、あるいは波束の収縮とは、このようなものだと理解するしかない。(この観測もリアル量子コンピュータではなく、それらしくシミュレートしたものであることは言うまでもない)q-cmaでは正確な解が欲しい。となると、

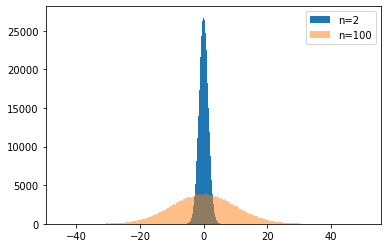

c.run()での覗き見を使うしかない。量子コンピュータと謳いながら・・・。シミュレーターさまさまである。念のために確認してみよう。

コード

probvect.pyfrom blueqat import Circuit import numpy as np import qcam # -------- Setting ------------------------------------------------------------------ N=8 # number of cells :You can change. R=1 # number of registries initial_a=np.array([0.4,0,1,0.5,1,0,0,0.2],dtype='float') # initial probability distribution :You can change. vector_a=np.array([[0]*N]*(2^N),dtype='int') csum_a=np.array([[0]*N]*(2^N),dtype='float') final_a=np.array([0]*N,dtype='float') #---------- Main Body ---------------------------------------------------------------- ret='y' while ret=='y': c=Circuit(N) qcam.propinit(N,c,initial_a) master_a=np.array(c.run()) num,vector_a,prob_a=qcam.qvextract(N,R,1,master_a) stdev,final_a=qcam.qcalcd(N, num,vector_a,prob_a) qcam.qcresultout(N, 0, num, initial_a, vector_a, prob_a,stdev, final_a) ret=input(' NEXT(Y/N)?')

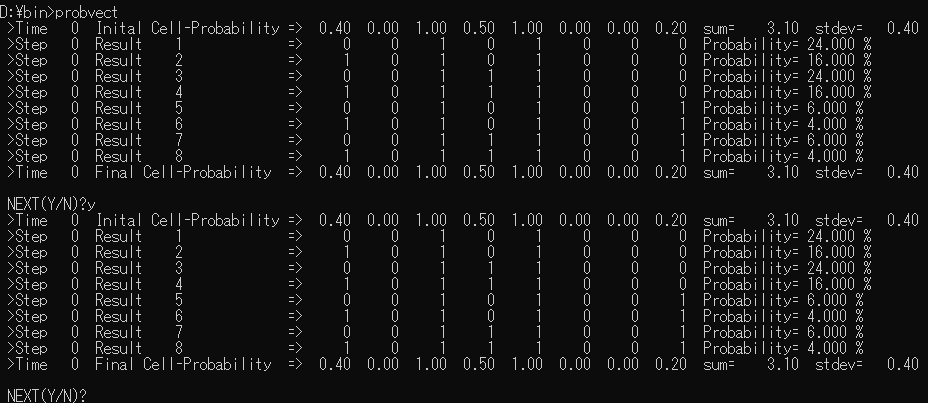

以下、コンソールでの実行結果である。

当たり前のことだが、Initial Cell-Probability と Final Cell-Probability は完全に一致する。第二回目のサマリー

1台の量子コンピュータで1000回繰り返し観測するのと、1回だけ1000台の量子コンピュータで観測するのと、同じ結果になるのか? エルゴート的には同じなんだろう。でも確率って、当たるも八卦当たらぬも八卦。次回、三回目は、がらっと変わって制御制御制御制御制御制御・・・ゲートの実装。

- 投稿日:2020-05-15T21:58:35+09:00

SwitchBot温湿度計の値をRaspberryPiでロギング

はじめに

本記事は、Omron環境センサ(BAG型)の記事と同内容を、

低価格で画面表示付きのSwitchBot温湿度センサで実施した記事です。SwitchBotとは?

中国・深圳のメーカーWonderlabs Inc.が開発した、家庭用IoT機器シリーズです。

今回は、上記シリーズの温湿度センサ

を使用します。

低価格(2000円くらい)でスマホアプリやAPIでのデータ取得、画面表示まで揃った多機能が魅力です。必要なもの

・RaspberryPi(今回はPi3Model Bを使用)

・Python実行環境(今回はpyenvでPython3.7.6使用)

・SwitchBot温湿度センサ手順

①RaspberryPiとセンサのBluetooth接続確認

②センサの測定値をPythonで取得

③PythonからGASのAPIを叩いてスプレッドシートにデータ書き込み

④スクリプトの定期実行こちらを参考にさせて頂きました。

https://qiita.com/warpzone/items/11ec9bef21f5b965bce3①RaspberrypiとセンサのBluetooth接続確認

センサの認識確認

・センサのセットアップ

センサに単4電池をセットします・Bluetooth機器のスキャン

SwitchBotの公式アプリでMACアドレスを確認したあと、

RaspberryPiで下記コマンドを実行sudo hcitool lescanLE Scan ... AA:EE:BB:DD:55:77 (unknown)上記で、アプリで確認したMACアドレスが出てくれば成功です。

②センサの測定値をPythonで取得

bluepyでの認識確認

bluepyは、PythonでBluetooth Low Energy(BLE)にアクセスするためのライブラリです(クラス定義)

・必要なパッケージのインストール

下記をインストールしますsudo install libglib2.0-dev・bluepyのインストール

下記コマンドでpipでインストールします

pip install bluepy・bluepyに権限を付与

スキャンにはbluepyにSudo権限を与える必要があります。bluepyのインストールされているフォルダに移動し、

cd ~.pyenv/versions/3.7.6/lib/python3.7/site-packages/bluepy※上記は、pyenvでPython3.7.6をインストールした場合。

環境により場所は異なるので注意下記コマンドでbluepy-helperにSudo権限を付与する

sudo setcap 'cap_net_raw,cap_net_admin+eip' bluepy-helperセンサ値取得スクリプトの作成

センサ値取得のため、下記のスクリプトを作成します

switchbot.pyfrom bluepy import btle import struct #Broadcastデータ取得用デリゲート class SwitchbotScanDelegate(btle.DefaultDelegate): #コンストラクタ def __init__(self, macaddr): btle.DefaultDelegate.__init__(self) #センサデータ保持用変数 self.sensorValue = None self.macaddr = macaddr # スキャンハンドラー def handleDiscovery(self, dev, isNewDev, isNewData): # 対象Macアドレスのデバイスが見つかったら if dev.addr == self.macaddr: # アドバタイズデータを取り出し for (adtype, desc, value) in dev.getScanData(): #環境センサのとき、データ取り出しを実行 if desc == '16b Service Data': #センサデータ取り出し self._decodeSensorData(value) # センサデータを取り出してdict形式に変換 def _decodeSensorData(self, valueStr): #文字列からセンサデータ(4文字目以降)のみ取り出し、バイナリに変換 valueBinary = bytes.fromhex(valueStr[4:]) #バイナリ形式のセンサデータを数値に変換 batt = valueBinary[2] & 0b01111111 isTemperatureAboveFreezing = valueBinary[4] & 0b10000000 temp = ( valueBinary[3] & 0b00001111 ) / 10 + ( valueBinary[4] & 0b01111111 ) if not isTemperatureAboveFreezing: temp = -temp humid = valueBinary[5] & 0b01111111 #dict型に格納 self.sensorValue = { 'SensorType': 'SwitchBot', 'Temperature': temp, 'Humidity': humid, 'BatteryVoltage': batt }Omron環境センサBAG版と同じ、ブロードキャストモードでセンサ値取得します。

取得したデータ内容が複雑だったので、上記の参考メインスクリプトの作成

センサ値取得スクリプトを呼び出すため、メインスクリプトを作成します

switchbot_toSpreadSheet.pyfrom bluepy import btle from switchbot import SwitchbotScanDelegate ######SwitchBotの値取得###### #switchbot.pyのセンサ値取得デリゲートを、スキャン時実行に設定 scanner = btle.Scanner().withDelegate(SwitchbotScanDelegate()) #スキャンしてセンサ値取得(タイムアウト5秒) scanner.scan(5.0) #試しに温度を表示 print(scanner.delegate.sensorValue['Temperature']) #Googleスプレッドシートにアップロードする処理を④で記載コンソールから実行してみます

python switchbot_toSpreadSheet.py 25.49これで、Pythonでセンサ測定値を取得することができました。

③PythonからGASのAPIを叩いてスプレッドシートにデータ書き込み

オムロン環境センサの記事ご参照ください

④スクリプトの定期実行

オムロン環境センサの記事ご参照ください

- 投稿日:2020-05-15T21:20:51+09:00

英語論文の文章をショートカットキー1回で整形してDeepL翻訳に突っ込む

英語論文を読むとき一番大変なことといえば,DeepL翻訳にかけるために文をコピーした後,毎回整形することじゃないですか.(?)

その処理を自動化してショートカットキー一つで出来るようにしました.

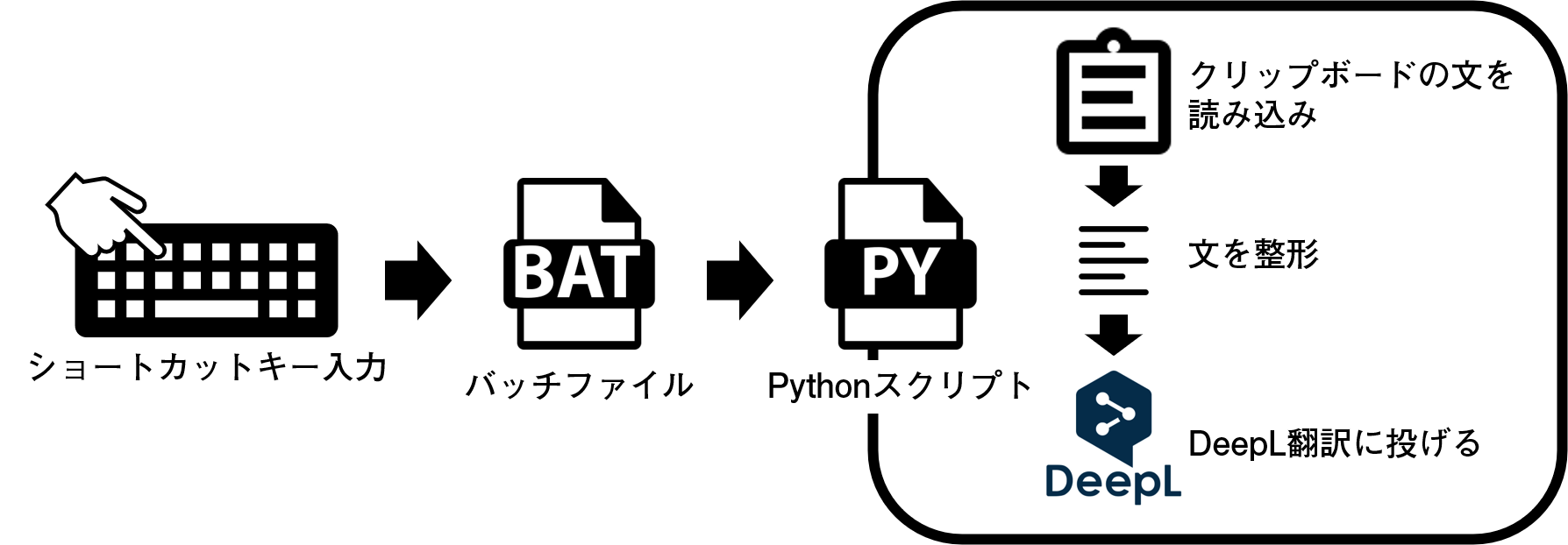

こんな感じです.Windowsを対象としています.方法

- Pythonスクリプトでクリップボードに格納されている文を取り出し,整形した後DeepL翻訳に投げます.

- このPythonスクリプトをバッチファイルから実行できるようにし,

- そのバッチファイルをショートカットキーから実行できるようにします.

Pythonスクリプト

ClipboardCopyToDeepL.pyimport pyperclip import webbrowser text = pyperclip.paste().replace("\n", " ").replace("- ", "") webbrowser.open("https://www.deepl.com/en/translator#en/ja/"+text.replace(" ", "%20"))(追記:間違っていたので,正規表現を使わない形に変更しました.)

いたってシンプルですが,pyperclipを使ってクリップボード上のテキストを取り出した後整形しています.

整形のルールは

- 英単語が改行で区切られている時に入る

-をなくす- 改行をスペースに置き換える

だけです.

最後にDeepL翻訳にWebリクエストを投げて終わりです.

DeepL翻訳はhttps://www.deepl.com/en/translator#en/ja/の末尾に翻訳したい文字列を入れてあげると翻訳結果が表示されるサイトに飛んでくれるのでそれを利用しました.このスクリプトをどこかに保存しておいて,バッチファイルでリクエストがあったときに実行されるようにします.

バッチファイル

pythonスクリプトと同じ階層に以下のバッチファイルを配置します

"Pythonの実行ディレクトリ" "pythonスクリプトのディレクトリ"例えばanacondaを利用しており,作成したスクリプトをデスクトップの"ClipboardCopyToDeepL/"以下に置いた場合は

ClipboardCopyToDeepL.batC:\Users\ユーザ名\anaconda3\python.exe C:\Users\ユーザ名\Desktop\ClipboardCopyToDeepL\ClipboardCopyToDeepL.pyとなります.

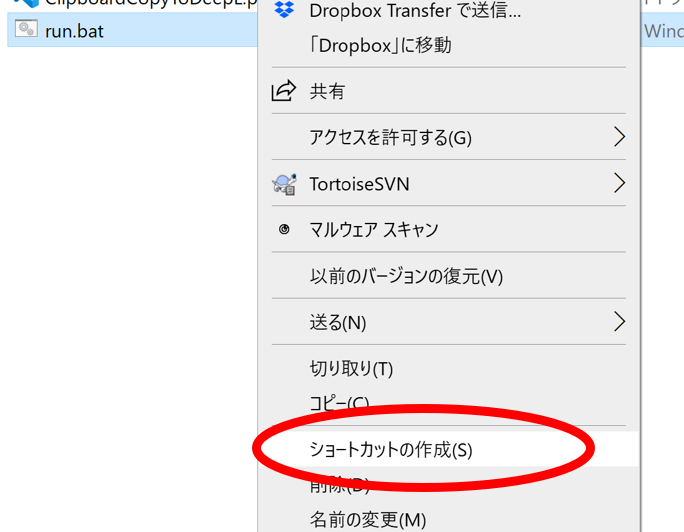

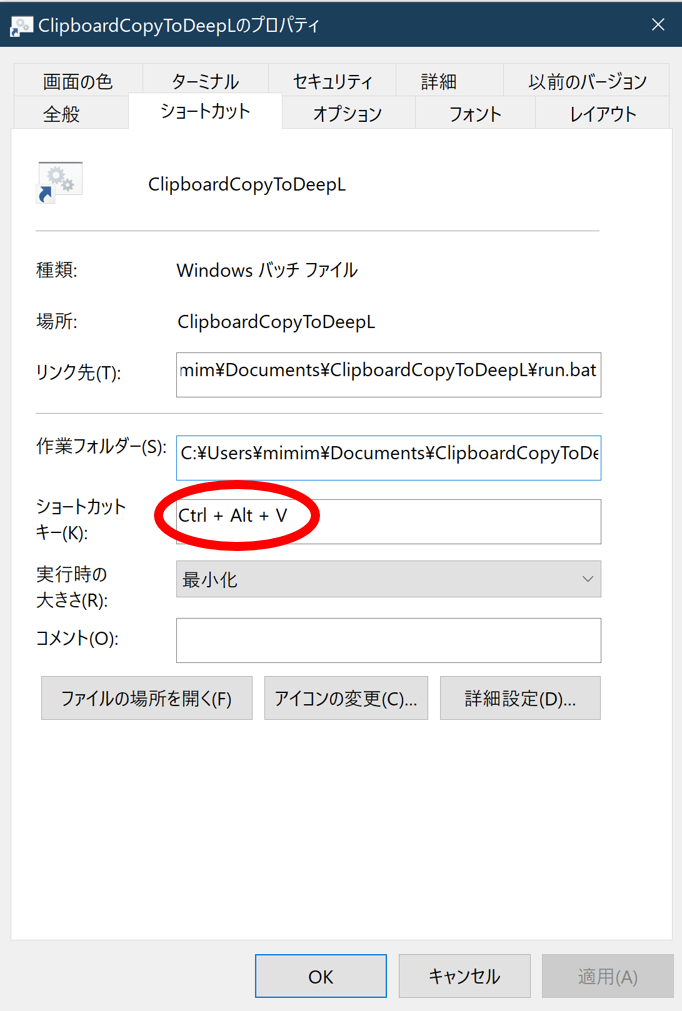

ショートカットキー割り当て

バッチファイルのショートカットを作成します.

ショートカットのプロパティから,ショートカットキーの設定を行います

枠をクリックして割り当てたいキーを打つと勝手に入力されます.(追記: 自分はこのショートカットを

C:\ProgramData\Microsoft\Windows\Start Menu\Programs\以下に配置すると使えるようになりました.)終わりに

これで論文が読むのが捗りますね.

- 投稿日:2020-05-15T21:20:51+09:00

論文の文章をショートカットキー1回で整形してDeepL翻訳に突っ込む

英語論文を読むとき一番大変なことといえば,DeepL翻訳にかけるために文をコピーした後,毎回整形することじゃないですか.(?)

その処理を自動化してショートカットキー一つで出来るようにしました.

こんな感じです.Windowsを対象としています.方法

- Pythonスクリプトでクリップボードに格納されている文を取り出し,整形した後DeepL翻訳に投げます.

- このPythonスクリプトをバッチファイルから実行できるようにし,

- そのバッチファイルをショートカットキーから実行できるようにします.

Pythonスクリプト

ClipboardCopyToDeepL.pyimport pyperclip import webbrowser text = pyperclip.paste().replace("\n", " ").replace("- ", "") webbrowser.open("https://www.deepl.com/en/translator#en/ja/"+text.replace(" ", "%20"))(追記:間違っていたので,正規表現を使わない形に変更しました.)

いたってシンプルですが,pyperclipを使ってクリップボード上のテキストを取り出した後整形しています.

整形のルールは

- 英単語が改行で区切られている時に入る

-をなくす- 改行をスペースに置き換える

だけです.

最後にDeepL翻訳にWebリクエストを投げて終わりです.

DeepL翻訳はhttps://www.deepl.com/en/translator#en/ja/の末尾に翻訳したい文字列を入れてあげると翻訳結果が表示されるサイトに飛んでくれるのでそれを利用しました.このスクリプトをどこかに保存しておいて,バッチファイルでリクエストがあったときに実行されるようにします.

バッチファイル

pythonスクリプトと同じ階層に以下のバッチファイルを配置します

"Pythonの実行ディレクトリ" "pythonスクリプトのディレクトリ"例えばanacondaを利用しており,作成したスクリプトをデスクトップの"ClipboardCopyToDeepL/"以下に置いた場合は

ClipboardCopyToDeepL.batC:\Users\ユーザ名\anaconda3\python.exe C:\Users\ユーザ名\Desktop\ClipboardCopyToDeepL\ClipboardCopyToDeepL.pyとなります.

ショートカットキー割り当て

バッチファイルのショートカットを作成します.

ショートカットのプロパティから,ショートカットキーの設定を行います

枠をクリックして割り当てたいキーを打つと勝手に入力されます.(追記: 自分はこのショートカットを

C:\ProgramData\Microsoft\Windows\Start Menu\Programs\以下に配置すると使えるようになりました.)終わりに

これで論文が読むのが捗りますね.

- 投稿日:2020-05-15T21:04:00+09:00

好きな芸能人のテレビ出演情報をLINEに通知する

目的

好きなアイドル、お笑い芸人がテレビに出演しているのを見逃してしまうので、LINEで通知するようにしました。

概要

Yahoo!テレビ Gガイドからテレビ番組の情報を取得し、LINENotifyを使って通知を行いました。毎朝9時にRaspberrypiでプログラムを実行するように設定しました。

番組情報取得

例えば、「眉村ちあき」の地上波の番組(地域設定東京)の場合はこのようなURLです。

https://tv.yahoo.co.jp/search/?q=眉村ちあき&g=0&a=23&oa=1&s=1tv_information(query,romaji,jenre)という関数を定義し、入力として通知したい芸能人の名前、出演番組を記録するテキストファイル名、通知したいtv番組のジャンルを受け取ります。入力に応じたURLから情報を取得しました。今回は東京の地上波の番組に限定しています。

お笑いコンビ、ニューヨークの情報を通知したかったのですがニューヨークのワードではアメリカの州のニューヨークに関連した番組がたくさん通知されてしまうので、番組のジャンルを指定して通知できるようにしています。すべてのジャンルはjenre=0、バラエティーはgenre=5を入力します。LINE

LINE Notify

ここからトークンを取得しました。

line_notify_token = "取得したLINE API"のところに取得したトークンを入力します。使ったコード

tv_line.pyimport requests from bs4 import BeautifulSoup import sys from time import sleep #テレビの情報を取得する(引数: 出演者の名前、ローマ字(ファイル名にする)、ジャンル) def tv_information(query,romaji,jenre): #すべてのジャンルなら0、バラエティーに絞るなら5 if jenre==0: no='' elif jenre==5: no='05' url = "https://tv.yahoo.co.jp/search/?q="+query+"&g="+no+"&a=23&oa=1&s=1" res = requests.get(url) status = res.status_code #Requestsのステータスコードが200でなければLINEに通知して終了する if status != 200: def LineNotify(message): line_notify_token = "取得したLINE API" line_notify_api = "https://notify-api.line.me/api/notify" payload = {"message": message} headers = {"Authorization": "Bearer " + line_notify_token} requests.post(line_notify_api, data=payload, headers=headers) message = "Requestsに失敗しました" LineNotify(message) sys.exit() #ステータスコードが200ならば処理継続 else: pass #キーワード検索数を取得 soup = BeautifulSoup(res.text,"html.parser") p = soup.find("p",class_="floatl pt5p") #検索数が0ならば処理終了 if p == None: print('0') non={} return non #検索数が1以上ならば処理継続 else: pass answer = int(p.em.text) #検索数 page = 1 list1 = [] #放送日時 list2 = [] #放送局 list3 = [] #番組タイトル #ページごとに情報取得 while answer > 0: url = "https://tv.yahoo.co.jp/search/?q="+query+"&g="+no+"&a=23&oa=1&s="+str(page) res = requests.get(url) soup = BeautifulSoup(res.text, "html.parser") dates = soup.find_all("div",class_="leftarea") for date in dates: d = date.text d = ''.join(d.splitlines()) list1.append(d) for s in soup("span",class_="floatl"): s.decompose() tvs = soup.find_all("span",class_="pr35") for tv in tvs: list2.append(tv.text) titles = soup.find_all("div",class_="rightarea") for title in titles: t = title.a.text list3.append(t) page = page + 10 answer = answer - 10 sleep(3) #list1~list3から放送日時+放送局+番組タイトルをまとめたlist_newの作成 list_new = [x +" "+ y for (x , y) in zip(list1,list2)] list_new = [x +" "+ y for (x , y) in zip(list_new,list3)] filename=romaji+'.txt' #テキストファイルから前回のデータを集合として展開する f = open(filename,'r') f_old = f.read() list_old = f_old.splitlines() set_old = set(list_old) f.close() f = open(filename, 'w') for x in list_new: f.write(str(x)+"\n") #ファイル書き込み f.close() #前回のデータと今回のデータの差集合をとる set_new = set(list_new) set_dif = set_new - set_old return set_dif def LINE_notify(set_dif,query,romaji): #差集合がなければ処理終了 if len(set_dif) == 0: return #差集合があればリストとして取り出してLINEに通知する else: list_now = list(set_dif) list_now.sort() for L in list_now: def LineNotify(message): line_notify_token = "取得したLINE API" line_notify_api = "https://notify-api.line.me/api/notify" payload = {"message": message} headers = {"Authorization": "Bearer " + line_notify_token} requests.post(line_notify_api, data=payload, headers=headers) message = query+"の出演番組情報\n\n" + L LineNotify(message) sleep(2) return # すべてのジャンルの眉村ちあきの出演番組を通知 set_dif1=tv_information('眉村ちあき','mayumura',0) LINE_notify(set_dif1,'眉村ちあき','mayumura') # すべてのジャンルの空気階段の出演番組を通知 set_dif2=tv_information('空気階段','kuuki',0) LINE_notify(set_dif2,'空気階段','kuuki') # バラエティーのジャンルのニューヨークの出演番組を通知 set_dif3=tv_information('ニューヨーク','newy',5) LINE_notify(set_dif3,'ニューヨーク','newy')実行

毎日朝9時にRaspberrypiでこのプログラムを実行するようにしました。

crontab -eでファイルに以下の文を書き込みました。00 09 * * * python3 /home/pi/tv_line.py実行時間の後にジョブを書きます。実行時間は、分、時、日、月、曜日の順で書きます。

参考

Yahooテレビ番組表から情報取得(Webスクレイピング初級)

浜辺美波の出演番組をスクレイピングで取得

crontabコマンドについてまとめました 【Linuxコマンド集】

- 投稿日:2020-05-15T20:58:16+09:00

Pythonを使ってCovid-19(コロナ)のデータを分析しよう【初心者向け】

海外youtubeで、Pythonを使って、Covid-19(コロナ)の感染者数などのデータを使ってデータ分析をするレクチャー動画があったのでやってみました。

出典動画はこちら↓

Analyzing Coronavirus with Python (COVID-19) by NeuralNine on Youtube対象

Pythonの初心者で、Pandasに慣れたいデータ分析をしてみたい方に特におすすめです。

レクチャーは英語ですが、とても平易かつ丁寧な解説なので是非見てみて下さい。本記事について

- Jupyter notebook上で日本語でコメントを入れながら、当該動画の演習を行いました。実際に動画を見ながら演習を行うのがおすすめですが、英語が苦手な方やデータ分析の流れを把握したい方が、ざっとこの記事を読むだけでもイメージをつかめるように書いています。

- リアルデータ(※出典は後述)を利用していますが、データ分析プロセスとしては特にシャープな分析結果を目的としているものではなく、(Pandasライブラリ等の)演習に重きを置いたものになります。

- 2020/5/1までのデータを利用しています。(※レクチャー動画は、撮影時の3/22までのデータ)

演習

Analyzing Coronavirus with Python (COVID-19) by NeuralNine on Youtube

データセットは以下のサイトからダウンロード

HDX(HUMANITARIAN DATA EXCHANGE)リンク先のデータセットの以下のものを使用

- time_series_covid19_confirmed_global.csv

- time_series_covid19_deaths_global.csv

- time_series_covid19_recovered_global.csv【感染(確認)者,死者数,回復者数】 のデータです。

データの名前が長いので、以下のように変更します。

- time_series_covid19_confirmed_global.csv → covid_confirmed.csv

- time_series_covid19_deaths_global.csv → covid_deaths.csv

- time_series_covid19_recovered_global.csv → covid_recovered.csvライブラリをインポート

import pandas as pd import matplotlib.pyplot as plt %matplotlib inlineデータを読み込みます

confirmed = pd.read_csv("covid19_confirmed.csv") deaths = pd.read_csv("covid19_deaths.csv") recovered = pd.read_csv("covid19_recovered.csv")試しに感染者のデータを表示させます(※ 元の動画では、撮影時時点の3/22のデータですが、以下は5/1まで)

confirmed.head()

Province/State Country/Region Lat Long 1/22/20 1/23/20 1/24/20 1/25/20 1/26/20 1/27/20 ... 4/22/20 4/23/20 4/24/20 4/25/20 4/26/20 4/27/20 4/28/20 4/29/20 4/30/20 5/1/20 0 NaN Afghanistan 33.0000 65.0000 0 0 0 0 0 0 ... 1176 1279 1351 1463 1531 1703 1828 1939 2171 2335 1 NaN Albania 41.1533 20.1683 0 0 0 0 0 0 ... 634 663 678 712 726 736 750 766 773 782 2 NaN Algeria 28.0339 1.6596 0 0 0 0 0 0 ... 2910 3007 3127 3256 3382 3517 3649 3848 4006 4154 3 NaN Andorra 42.5063 1.5218 0 0 0 0 0 0 ... 723 723 731 738 738 743 743 743 745 745 4 NaN Angola -11.2027 17.8739 0 0 0 0 0 0 ... 25 25 25 25 26 27 27 27 27 30 5 rows × 105 columns

※ 緯度(Lat),経度(Long)

今回は、ProvinceとLat/Longはあまり必要でないので、列ごと消します

confirmed = confirmed.drop(['Province/State','Lat','Long'],axis=1) deaths = deaths.drop(['Province/State','Lat','Long'],axis=1) recovered = recovered.drop(['Province/State','Lat','Long'],axis=1)このデータを、Country/Regionごとに集計してみましょう

confirmed = confirmed.groupby(confirmed["Country/Region"]).aggregate("sum") deaths = deaths.groupby(deaths["Country/Region"]).aggregate("sum") recovered = recovered.groupby(recovered["Country/Region"]).aggregate("sum")confirmed.head()

1/22/20 1/23/20 1/24/20 1/25/20 1/26/20 1/27/20 1/28/20 1/29/20 1/30/20 1/31/20 ... 4/22/20 4/23/20 4/24/20 4/25/20 4/26/20 4/27/20 4/28/20 4/29/20 4/30/20 5/1/20 Country/Region Afghanistan 0 0 0 0 0 0 0 0 0 0 ... 1176 1279 1351 1463 1531 1703 1828 1939 2171 2335 Albania 0 0 0 0 0 0 0 0 0 0 ... 634 663 678 712 726 736 750 766 773 782 Algeria 0 0 0 0 0 0 0 0 0 0 ... 2910 3007 3127 3256 3382 3517 3649 3848 4006 4154 Andorra 0 0 0 0 0 0 0 0 0 0 ... 723 723 731 738 738 743 743 743 745 745 Angola 0 0 0 0 0 0 0 0 0 0 ... 25 25 25 25 26 27 27 27 27 30 5 rows × 101 columns

そして、次に、日付が特徴量となっていますが、今回は国を特徴量にしたいため、データを転置(行列入れ替え)します。

confirmed = confirmed.T deaths = deaths.T recovered = recovered.Tconfirmed.head()

Country/Region Afghanistan Albania Algeria Andorra Angola Antigua and Barbuda Argentina Armenia Australia Austria ... United Kingdom Uruguay Uzbekistan Venezuela Vietnam West Bank and Gaza Western Sahara Yemen Zambia Zimbabwe 1/22/20 0 0 0 0 0 0 0 0 0 0 ... 0 0 0 0 0 0 0 0 0 0 1/23/20 0 0 0 0 0 0 0 0 0 0 ... 0 0 0 0 2 0 0 0 0 0 1/24/20 0 0 0 0 0 0 0 0 0 0 ... 0 0 0 0 2 0 0 0 0 0 1/25/20 0 0 0 0 0 0 0 0 0 0 ... 0 0 0 0 2 0 0 0 0 0 1/26/20 0 0 0 0 0 0 0 0 4 0 ... 0 0 0 0 2 0 0 0 0 0 5 rows × 187 columns

ここまでで、データの下準備は一旦整いました。計算に移っていきます。

まず、感染者数の増加数の推移をみていきましょう

ここで必要になってくるデータは当該日とその前日の感染者数の差です。new_cases = confirmed.copy()for day in range(1,len(confirmed)): new_cases.iloc[day] = confirmed.iloc[day] - confirmed.iloc[day - 1]直近の10日分のデータを見ます

new_cases.tail(10)

Country/Region Afghanistan Albania Algeria Andorra Angola Antigua and Barbuda Argentina Armenia Australia Austria ... United Kingdom Uruguay Uzbekistan Venezuela Vietnam West Bank and Gaza Western Sahara Yemen Zambia Zimbabwe 4/22/20 84 25 99 6 1 1 113 72 7 52 ... 4466 8 38 3 0 8 0 0 4 0 4/23/20 103 29 97 0 0 0 291 50 10 77 ... 4608 14 42 23 0 6 0 0 2 0 4/24/20 72 15 120 8 0 0 172 73 15 69 ... 5394 6 46 7 2 4 0 0 8 1 4/25/20 112 34 129 7 0 0 173 81 17 77 ... 4929 33 58 5 0 -142 0 0 0 2 4/26/20 68 14 126 0 1 0 112 69 20 77 ... 4468 10 7 2 0 0 0 0 4 0 4/27/20 172 10 135 5 1 0 111 62 7 49 ... 4311 14 35 4 0 0 0 0 0 1 4/28/20 125 14 132 0 0 0 124 59 23 83 ... 4002 5 35 0 0 1 0 0 7 0 4/29/20 111 16 199 0 0 0 158 65 8 45 ... 4091 5 63 2 0 1 0 5 2 0 4/30/20 232 7 158 2 0 0 143 134 14 50 ... 6040 13 37 2 0 0 0 0 9 8 5/1/20 164 9 148 0 3 1 104 82 12 79 ... 6204 5 47 2 0 9 0 1 3 0 10 rows × 187 columns

感染者データと比べてみましょう

confirmed.tail(10)

Country/Region Afghanistan Albania Algeria Andorra Angola Antigua and Barbuda Argentina Armenia Australia Austria ... United Kingdom Uruguay Uzbekistan Venezuela Vietnam West Bank and Gaza Western Sahara Yemen Zambia Zimbabwe 4/22/20 1176 634 2910 723 25 24 3144 1473 6652 14925 ... 134638 543 1716 288 268 474 6 1 74 28 4/23/20 1279 663 3007 723 25 24 3435 1523 6662 15002 ... 139246 557 1758 311 268 480 6 1 76 28 4/24/20 1351 678 3127 731 25 24 3607 1596 6677 15071 ... 144640 563 1804 318 270 484 6 1 84 29 4/25/20 1463 712 3256 738 25 24 3780 1677 6694 15148 ... 149569 596 1862 323 270 342 6 1 84 31 4/26/20 1531 726 3382 738 26 24 3892 1746 6714 15225 ... 154037 606 1869 325 270 342 6 1 88 31 4/27/20 1703 736 3517 743 27 24 4003 1808 6721 15274 ... 158348 620 1904 329 270 342 6 1 88 32 4/28/20 1828 750 3649 743 27 24 4127 1867 6744 15357 ... 162350 625 1939 329 270 343 6 1 95 32 4/29/20 1939 766 3848 743 27 24 4285 1932 6752 15402 ... 166441 630 2002 331 270 344 6 6 97 32 4/30/20 2171 773 4006 745 27 24 4428 2066 6766 15452 ... 172481 643 2039 333 270 344 6 6 106 40 5/1/20 2335 782 4154 745 30 25 4532 2148 6778 15531 ... 178685 648 2086 335 270 353 6 7 109 40 10 rows × 187 columns

例えば、AfghanistanやAlgeriaやArgentinaやUnited Kingdomは、感染者数の絶対数も多いですが、新規感染者数も依然多いということが分かります。

new_casesでは、感染者数の日別の"増加数"を見ましたが、次に"増加率"を見ましょう。

(当該日の増加数 / 前日の感染者数) * 100 で増加率を出すことが出来ますgrowth_rate = confirmed.copy() for day in range(1,len(growth_rate)): growth_rate.iloc[day] = ( new_cases.iloc[day] / confirmed.iloc[day-1] ) * 100growth_rate.tail(10)

Country/Region Afghanistan Albania Algeria Andorra Angola Antigua and Barbuda Argentina Armenia Australia Austria ... United Kingdom Uruguay Uzbekistan Venezuela Vietnam West Bank and Gaza Western Sahara Yemen Zambia Zimbabwe 4/22/20 7.692308 4.105090 3.521878 0.836820 4.166667 4.347826 3.728143 5.139186 0.105342 0.349627 ... 3.430845 1.495327 2.264601 1.052632 0.000000 1.716738 0.0 0.000000 5.714286 0.000000 4/23/20 8.758503 4.574132 3.333333 0.000000 0.000000 0.000000 9.255725 3.394433 0.150331 0.515913 ... 3.422511 2.578269 2.447552 7.986111 0.000000 1.265823 0.0 0.000000 2.702703 0.000000 4/24/20 5.629398 2.262443 3.990688 1.106501 0.000000 0.000000 5.007278 4.793171 0.225158 0.459939 ... 3.873720 1.077199 2.616610 2.250804 0.746269 0.833333 0.0 0.000000 10.526316 3.571429 4/25/20 8.290155 5.014749 4.125360 0.957592 0.000000 0.000000 4.796230 5.075188 0.254605 0.510915 ... 3.407771 5.861456 3.215078 1.572327 0.000000 -29.338843 0.0 0.000000 0.000000 6.896552 4/26/20 4.647984 1.966292 3.869779 0.000000 4.000000 0.000000 2.962963 4.114490 0.298775 0.508318 ... 2.987250 1.677852 0.375940 0.619195 0.000000 0.000000 0.0 0.000000 4.761905 0.000000 4/27/20 11.234487 1.377410 3.991721 0.677507 3.846154 0.000000 2.852004 3.550974 0.104260 0.321839 ... 2.798678 2.310231 1.872659 1.230769 0.000000 0.000000 0.0 0.000000 0.000000 3.225806 4/28/20 7.339988 1.902174 3.753199 0.000000 0.000000 0.000000 3.097677 3.263274 0.342211 0.543407 ... 2.527345 0.806452 1.838235 0.000000 0.000000 0.292398 0.0 0.000000 7.954545 0.000000 4/29/20 6.072210 2.133333 5.453549 0.000000 0.000000 0.000000 3.828447 3.481521 0.118624 0.293026 ... 2.519864 0.800000 3.249097 0.607903 0.000000 0.291545 0.0 500.000000 2.105263 0.000000 4/30/20 11.964930 0.913838 4.106029 0.269179 0.000000 0.000000 3.337223 6.935818 0.207346 0.324633 ... 3.628914 2.063492 1.848152 0.604230 0.000000 0.000000 0.0 0.000000 9.278351 25.000000 5/1/20 7.554123 1.164295 3.694458 0.000000 11.111111 4.166667 2.348690 3.969022 0.177357 0.511261 ... 3.596918 0.777605 2.305051 0.600601 0.000000 2.616279 0.0 16.666667 2.830189 0.000000 10 rows × 187 columns

さて、感染者数(confirmed)はいわゆる累計の数なので、一旦ここで、現在進行形の感染者数(Active)を出しましょう。

【感染者数(confirmed)】から【死者数(deaths)と回復者数(recovered)】を引くと、【現在進行形の感染者数(Active)】が計算できそうです。active_cases = confirmed.copy() for day in range(0,len(confirmed)): active_cases.iloc[day] = confirmed.iloc[day] - deaths.iloc[day] - recovered.iloc[day]そして、この現在進行形の感染者数active_casesのデータを利用して、再度、現在進行形の感染者数の増加率を調べましょう。

これを調べることによって、収束していそうかどうかが分かりそうです。overall_growth_rate = confirmed.copy() for day in range(0,len(confirmed)): overall_growth_rate.iloc[day] = ((active_cases.iloc[day] - active_cases.iloc[day-1]) / active_cases.iloc[day-1]) * 100overall_growth_rate.tail(10)

Country/Region Afghanistan Albania Algeria Andorra Angola Antigua and Barbuda Argentina Armenia Australia Austria ... United Kingdom Uruguay Uzbekistan Venezuela Vietnam West Bank and Gaza Western Sahara Yemen Zambia Zimbabwe 4/22/20 7.064018 5.462185 2.920284 -5.276382 6.250000 -15.384615 3.718200 6.250000 -12.214551 -9.498681 ... 3.270797 -1.895735 -4.258555 -1.265823 -13.461538 2.046036 0.000000 0.000000 12.500000 -4.347826 4/23/20 9.072165 0.000000 -4.524540 -6.366048 0.000000 0.000000 10.896226 2.941176 -6.836056 -9.750567 ... 3.411790 -7.729469 -5.480540 12.179487 -2.222222 -3.759398 -83.333333 0.000000 0.000000 0.000000 4/24/20 5.860113 2.390438 4.738956 -1.699717 0.000000 -9.090909 4.423650 0.119048 -5.064935 -4.199569 ... 3.743980 -4.712042 -1.260504 0.571429 13.636364 1.041667 0.000000 -100.000000 22.222222 4.545455 4/25/20 9.642857 9.727626 4.141104 2.017291 0.000000 0.000000 4.480652 0.594530 -15.321477 -5.994755 ... 3.332975 16.483516 -2.382979 2.840909 -10.000000 -36.082474 0.000000 NaN 0.000000 8.695652 4/26/20 3.745928 2.127660 6.701031 0.000000 5.882353 0.000000 1.091618 4.609929 -11.954766 -4.304504 ... 3.232666 1.886792 -6.538797 -1.657459 0.000000 3.629032 0.000000 NaN -2.272727 0.000000 4/27/20 11.930926 -0.694444 5.383023 -10.169492 5.555556 0.000000 2.815272 5.197740 -3.669725 -1.582674 ... 3.051680 1.388889 -6.343284 -0.561798 0.000000 0.000000 0.000000 NaN 0.000000 -8.000000 4/28/20 8.134642 1.048951 2.226588 -4.402516 0.000000 0.000000 3.450863 4.296455 -5.714286 -6.559458 ... 2.318102 -1.369863 -6.474104 0.000000 6.666667 5.058366 0.000000 NaN 16.279070 0.000000 4/29/20 5.512322 -2.768166 9.032671 -8.552632 -5.263158 0.000000 4.387237 3.192585 -4.444444 -7.472826 ... 2.386758 -6.018519 -4.472843 1.129944 0.000000 0.370370 0.000000 inf -20.000000 0.000000 4/30/20 13.521819 -3.202847 4.406580 -15.467626 0.000000 0.000000 2.605071 10.279441 -1.585624 -4.013705 ... 3.845988 2.955665 0.000000 -2.234637 6.250000 -1.845018 0.000000 -40.000000 20.000000 34.782609 5/1/20 5.955604 -3.308824 5.796286 -0.425532 -5.555556 -30.000000 2.064997 2.986425 -2.255639 -6.578276 ... 3.750518 -6.220096 -3.567447 1.142857 0.000000 3.383459 0.000000 33.333333 -33.333333 0.000000 10 rows × 187 columns

直近10日(2020/04/22-05/01)の現在進行形の感染者数の増加率 (中国・イタリア・アメリカ・日本)

※ ちょこっと、ここの部分にオリジナルの加えています。

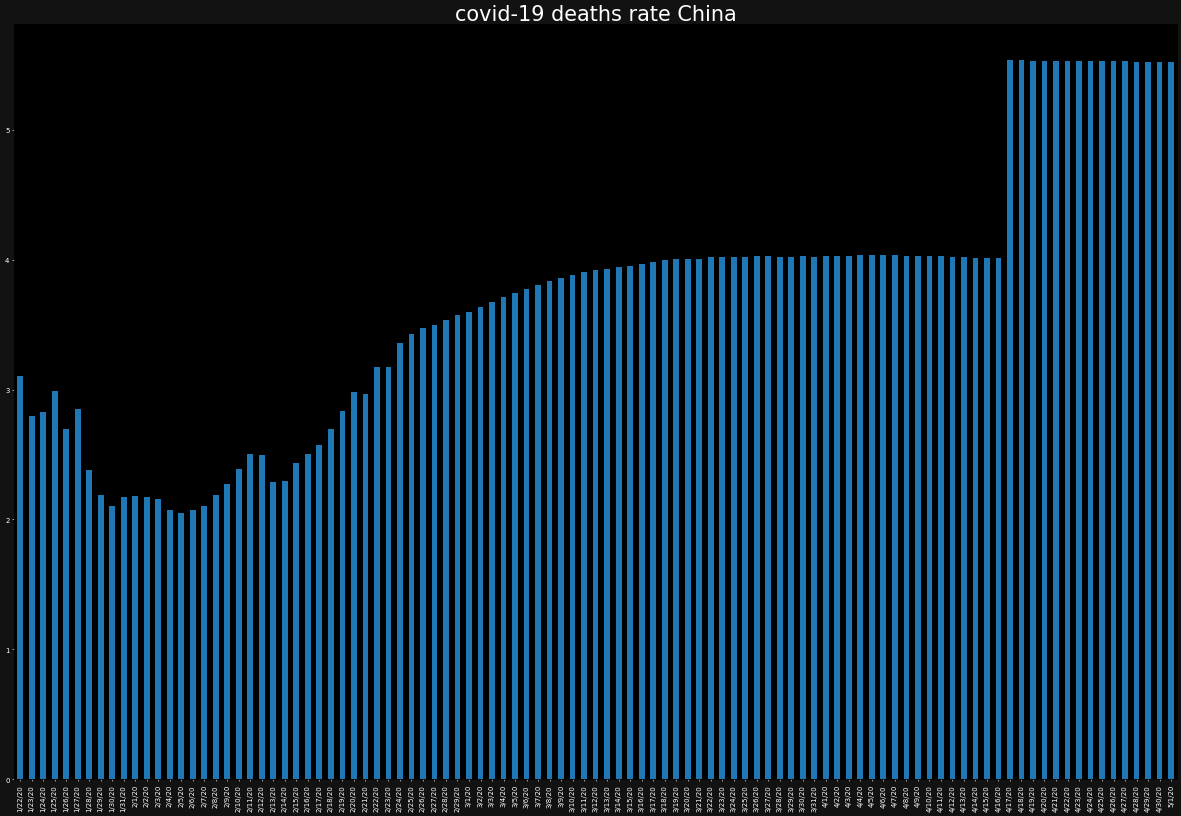

まず、コロナ発症国と考えられている中国は、最近収束しているみたいなので、中国の直近10日のデータを見てみましょう

overall_growth_rate['China'].tail(10)4/22/20 -3.314528 4/23/20 -7.731583 4/24/20 -8.774704 4/25/20 -4.852686 4/26/20 -9.107468 4/27/20 -9.118236 4/28/20 -2.866593 4/29/20 -5.448354 4/30/20 -4.441777 5/1/20 -5.904523 Name: China, dtype: float64増加率マイナス、つまり現在進行形の感染者数が減り続けている → 収束に向かっていることが分かります。

次に、イタリアはどうでしょうか。

overall_growth_rate['Italy'].tail(10)4/22/20 -0.009284 4/23/20 -0.790165 4/24/20 -0.300427 4/25/20 -0.638336 4/26/20 0.241859 4/27/20 -0.273319 4/28/20 -0.574599 4/29/20 -0.520888 4/30/20 -2.967790 5/1/20 -0.598714 Name: Italy, dtype: float641%未満の減少率なので微減ですが、増えてはいません。

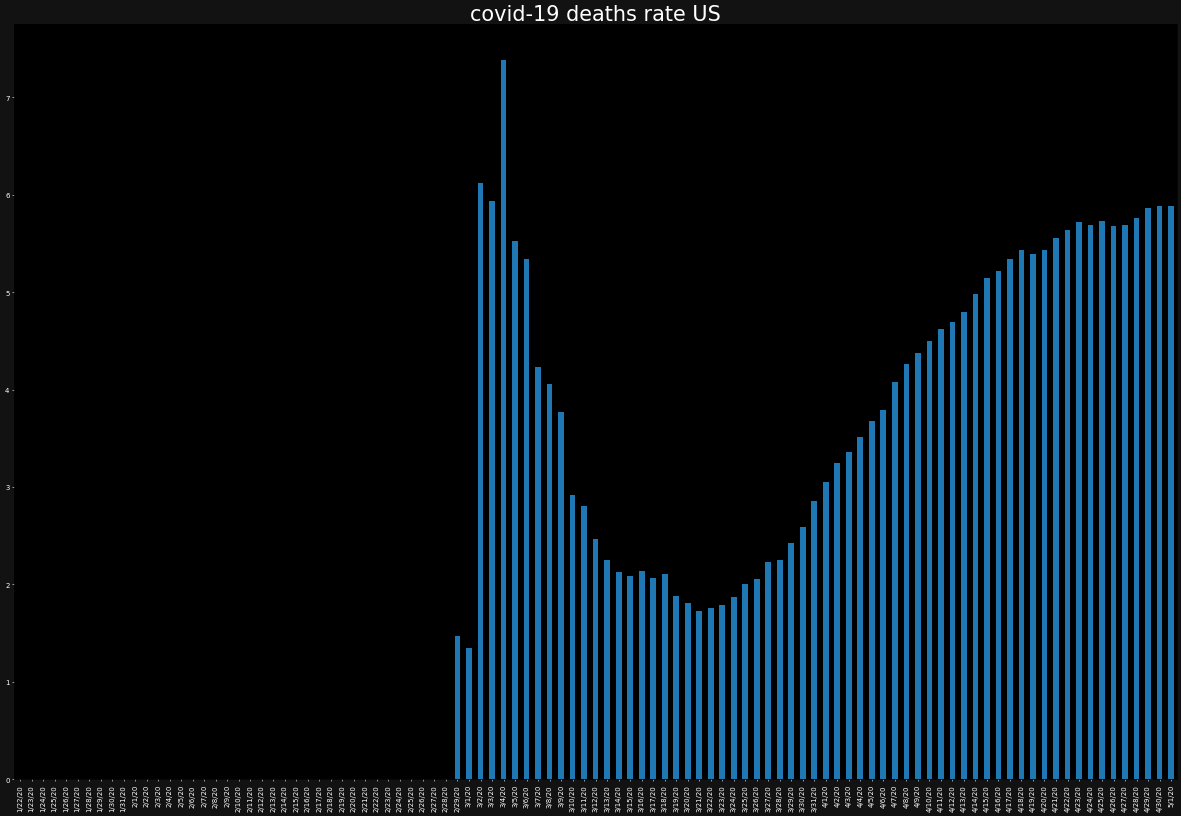

overall_growth_rate['US'].tail(10)4/22/20 3.470050 4/23/20 3.307839 4/24/20 2.102556 4/25/20 3.874078 4/26/20 2.536775 4/27/20 2.064644 4/28/20 2.166569 4/29/20 2.377575 4/30/20 -0.668941 5/1/20 2.583283 Name: US, dtype: float64アメリカは、まだ数%ずつ増加しています。

overall_growth_rate['Japan'].tail(10)4/22/20 2.512198 4/23/20 6.794937 4/24/20 3.868765 4/25/20 2.382691 4/26/20 0.401248 4/27/20 5.408526 4/28/20 -3.589182 4/29/20 -2.875120 4/30/20 0.755803 5/1/20 -2.884444 Name: Japan, dtype: float64日本も、ちょっとずつ直近で減ってきた感じはありますが、増加傾向にあります。

日本は、せっかくなので、直近10日の増加率の平均を見てみましょう。

overall_growth_rate['Japan'].tail(10).mean()1.2775422886005911%程度ですが、増加傾向にある感じです。まぁ、日本はまだ感染者数も少ないので、比較的抑えられているといえるかもしれません。

ここから可視化(visualization)を交えていきます。

最初に死亡率を見ていきましょう。死亡率は、地域ごとのコロナの深刻さを表す指標となるので重要です。

まず、死亡率のデータフレームは、先ほどの手順とほぼ同様です。死亡率は、死亡者/感染者 で表されます。

death_rate = confirmed.copy()for day in range(0,len(confirmed)): death_rate.iloc[day] = (deaths.iloc[day] / confirmed.iloc[day]) * 100次に、必要な必要なベッド台数(逆に、どれだけ不足が生じそうか)を算出します。

感染者のうち病院が必要な人の割合である入院率"hospitalization"を用います。これは、正しい数値は、分からないので、一旦仮の数値(ここでは、0.05)を用います。好きな数字に変えても大丈夫です。このレクチャーでは、分析・計算手法にフォーカスするため、一旦正確さは置いておきます。※ちなみに、入院率は、コロナ陽性かつ入院が必要な人のことで、残りの95%は陽性であっても、入院(ベッド)は必要ではないとみなしています。

hospitalization_rate_estimate = 0.05hospitalization_needed = confirmed.copy()for day in range(0,len(confirmed)): hospitalization_needed.iloc[day] = active_cases.iloc[day] * hospitalization_rate_estimatehospitalization_needed.tail()

Country/Region Afghanistan Albania Algeria Andorra Angola Antigua and Barbuda Argentina Armenia Australia Austria ... United Kingdom Uruguay Uzbekistan Venezuela Vietnam West Bank and Gaza Western Sahara Yemen Zambia Zimbabwe 4/27/20 71.30 14.30 76.35 15.90 0.95 0.50 133.30 46.55 52.50 118.15 ... 6654.15 10.95 50.20 8.85 2.25 12.85 0.05 0.00 2.15 1.15 4/28/20 77.10 14.45 78.05 15.20 0.95 0.50 137.90 48.55 49.50 110.40 ... 6808.40 10.80 46.95 8.85 2.40 13.50 0.05 0.00 2.50 1.15 4/29/20 81.35 14.05 85.10 13.90 0.90 0.50 143.95 50.10 47.30 102.15 ... 6970.90 10.15 44.85 8.95 2.40 13.55 0.05 0.25 2.00 1.15 4/30/20 92.35 13.60 88.85 11.75 0.90 0.50 147.70 55.25 46.55 98.05 ... 7239.00 10.45 44.85 8.75 2.55 13.30 0.05 0.15 2.40 1.55 5/1/20 97.85 13.15 94.00 11.70 0.85 0.35 150.75 56.90 45.50 91.60 ... 7510.50 9.80 43.25 8.85 2.55 13.75 0.05 0.20 1.60 1.55 5 rows × 187 columns

一旦、ここで国をひとつ取り出しても、どれだけ深刻かわかりづらいため、一旦直近5日の平均を見ます。

hospitalization_needed.tail().mean().mean()532.5691978609626直近5日のすべての国の必要ベッド数の平均です。ばらつきも当然あるため、あまり理想的な参考値ではないですが、一旦これを参考とします。

イタリアの直近5日の平均を見てみましょう。hospitalization_needed['Italy'].tail().mean()5181.6900000000005つまり、ざっと世界中の平均の10倍という数値が出ました。かなり深刻です。

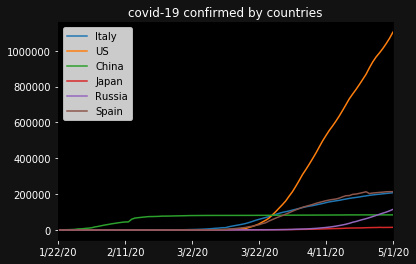

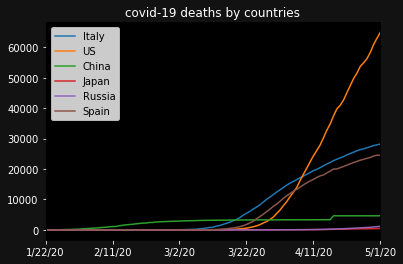

可視化します。ただ、国が多すぎるので、今回は、いくつか任意の国を選びましょう。ここでは、イタリア、アメリカ、中国、日本、ロシア スペインを選びます。

countries = ['Italy','US',"China","Japan","Russia","Spain"]ax = plt.subplot() ax.set_facecolor("black") ax.figure.set_facecolor("#121212") ax.tick_params(axis="x",colors="white") ax.tick_params(axis="y",colors="white") ax.set_title("covid-19 confirmed by countries",color="white") for country in countries: confirmed[country].plot(label=country) plt.legend(loc="upper left") plt.show()USが3月末ぐらいから著しく感染者が増えていますね。

死者数を見ましょう。グラフの形はあまり変わらず、感染者数に伴っているような感じです。

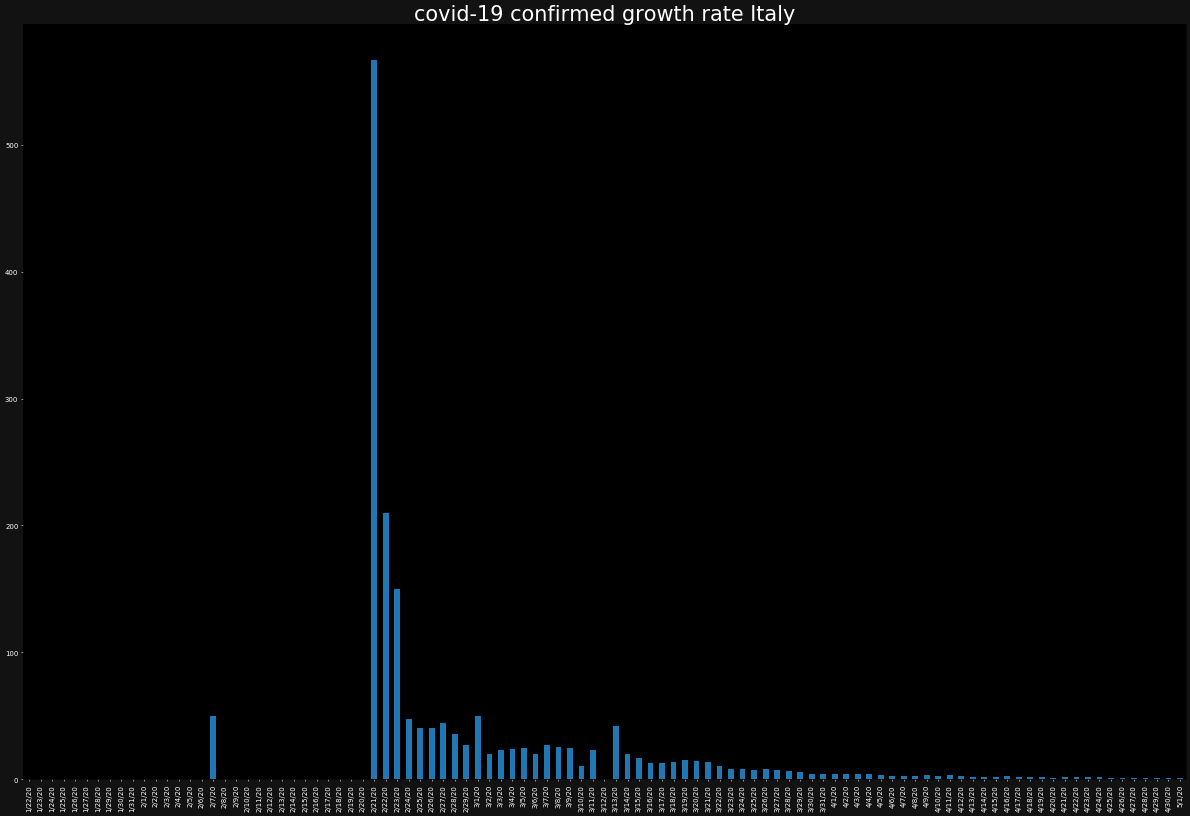

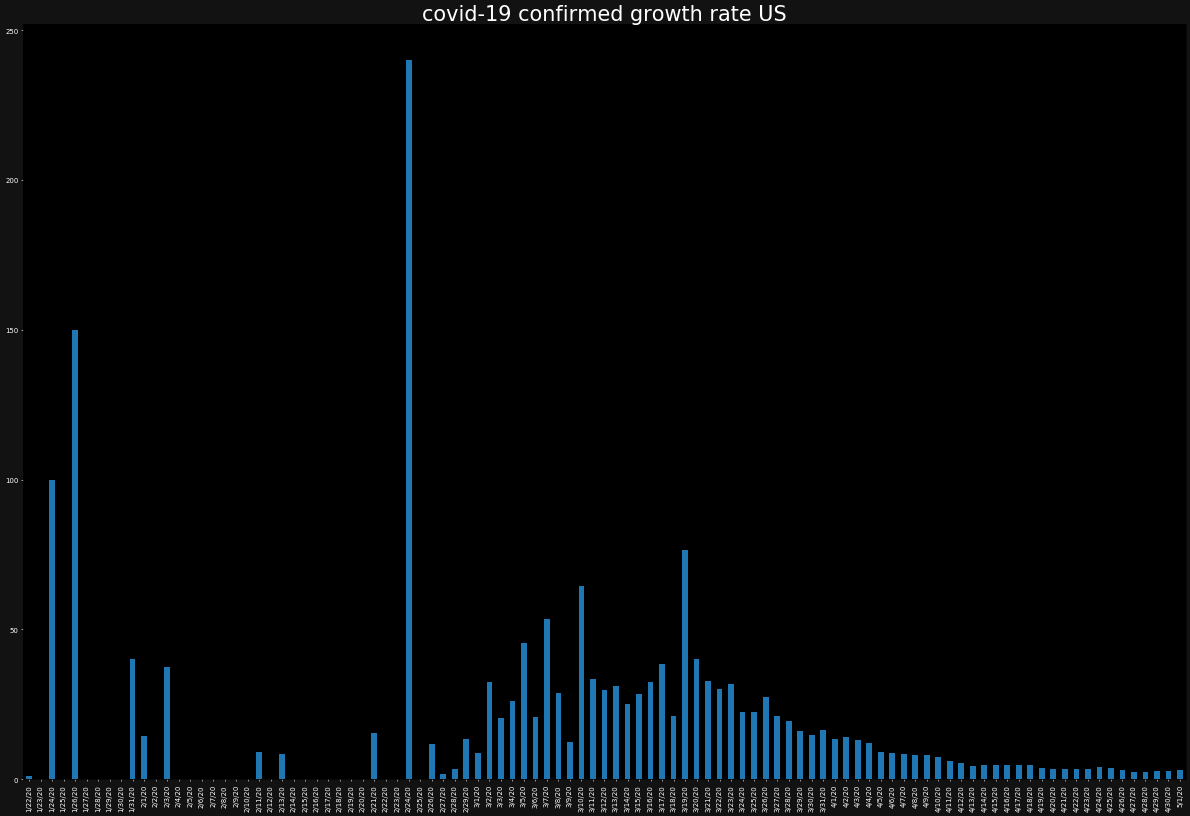

次に、感染者の増加率をプロットしてみましょう。

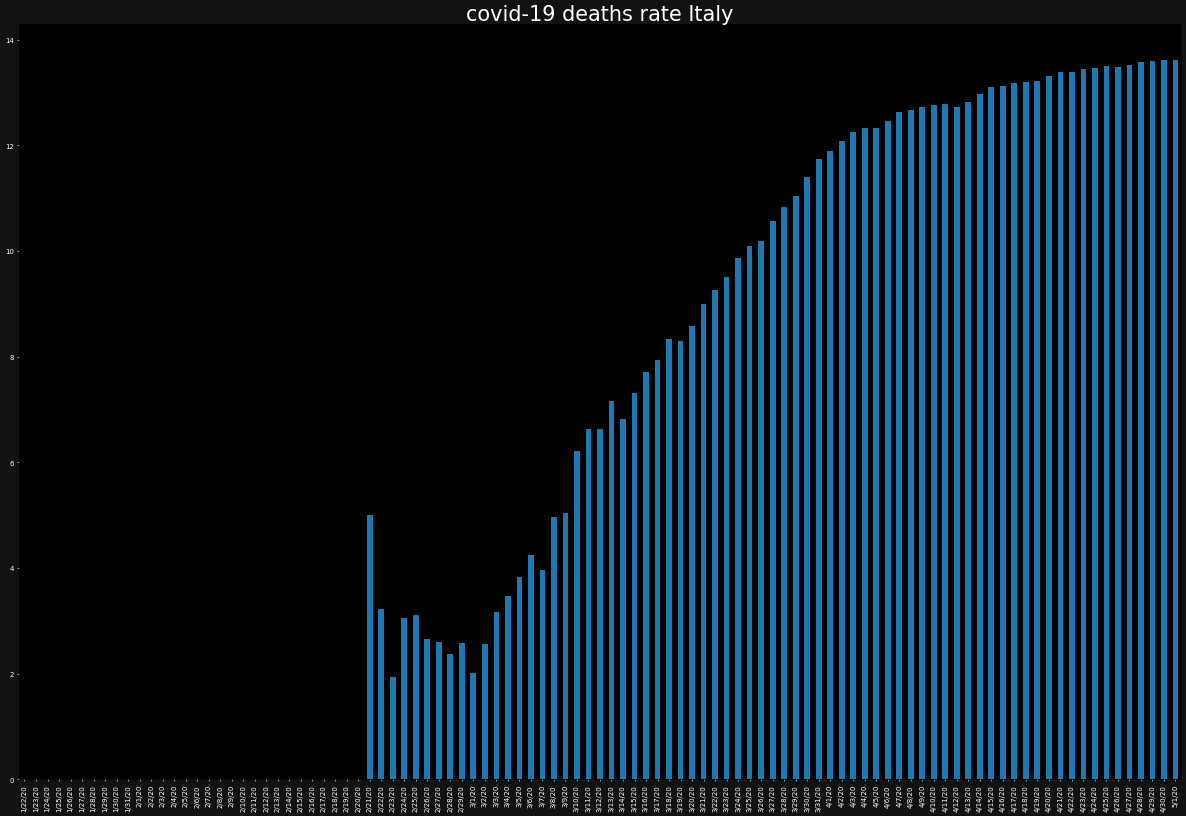

ただし、今度は、バーチャートでプロットします。また、バーチャートではあまりひとつの図にグラフが重なりすぎると、可視性が低くなるため別々に表示します。

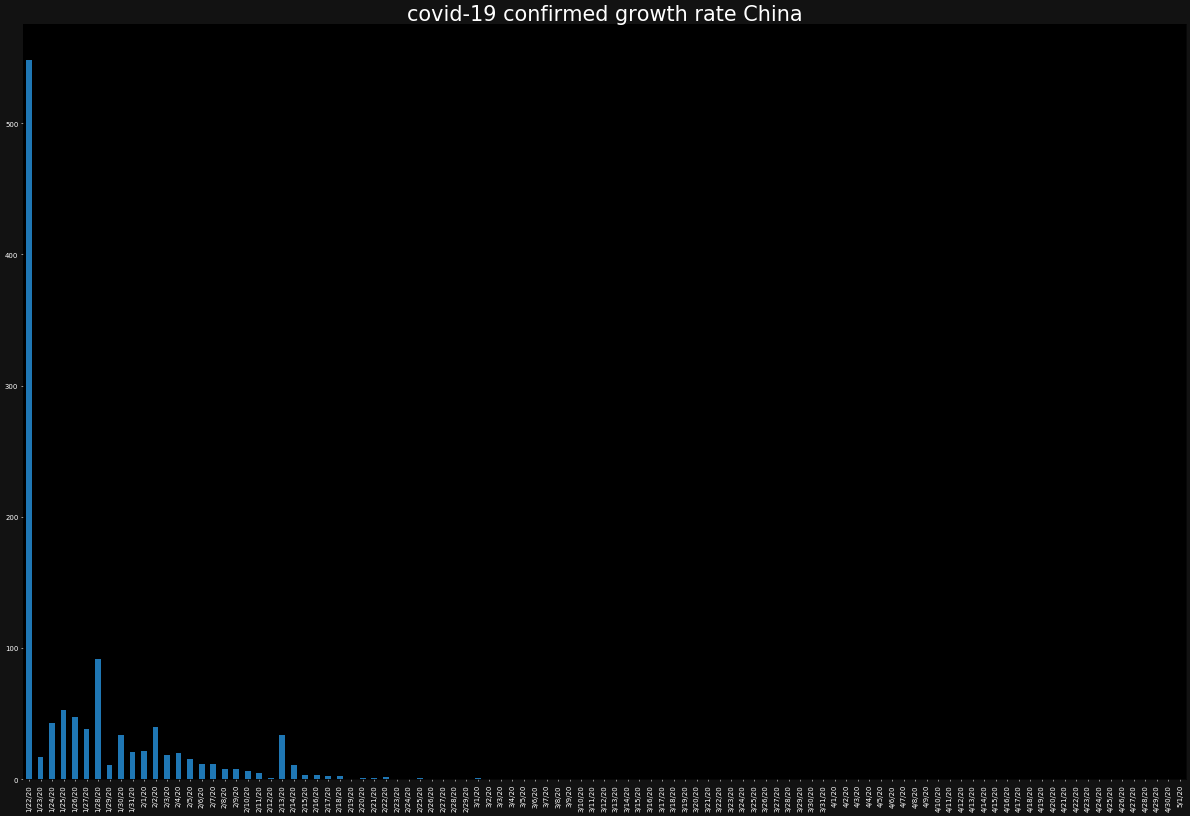

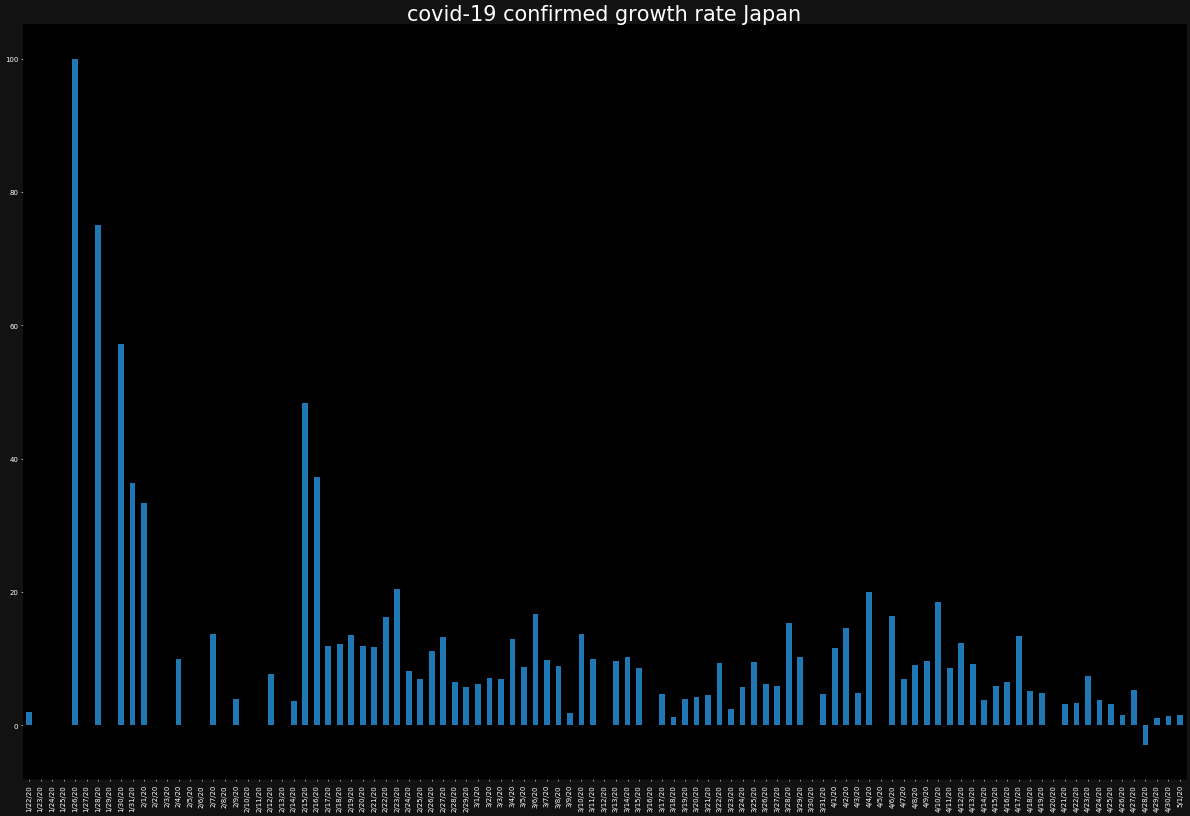

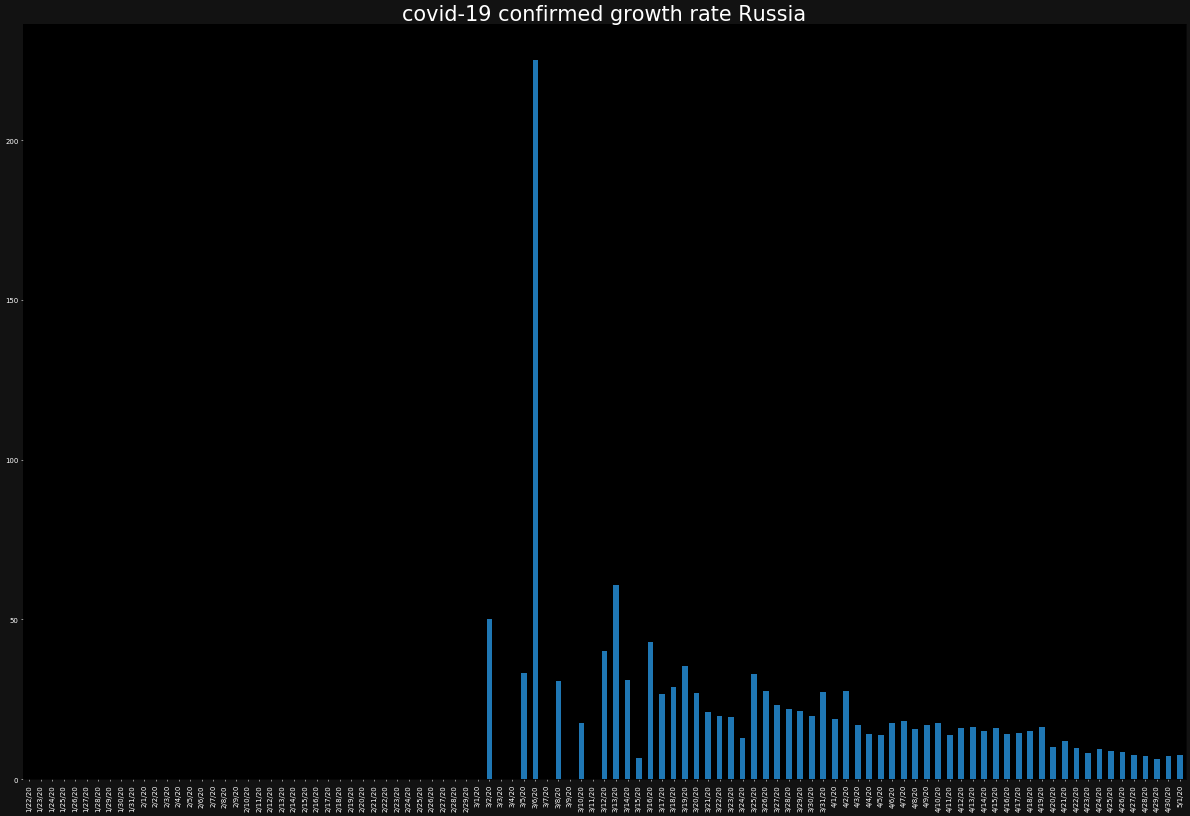

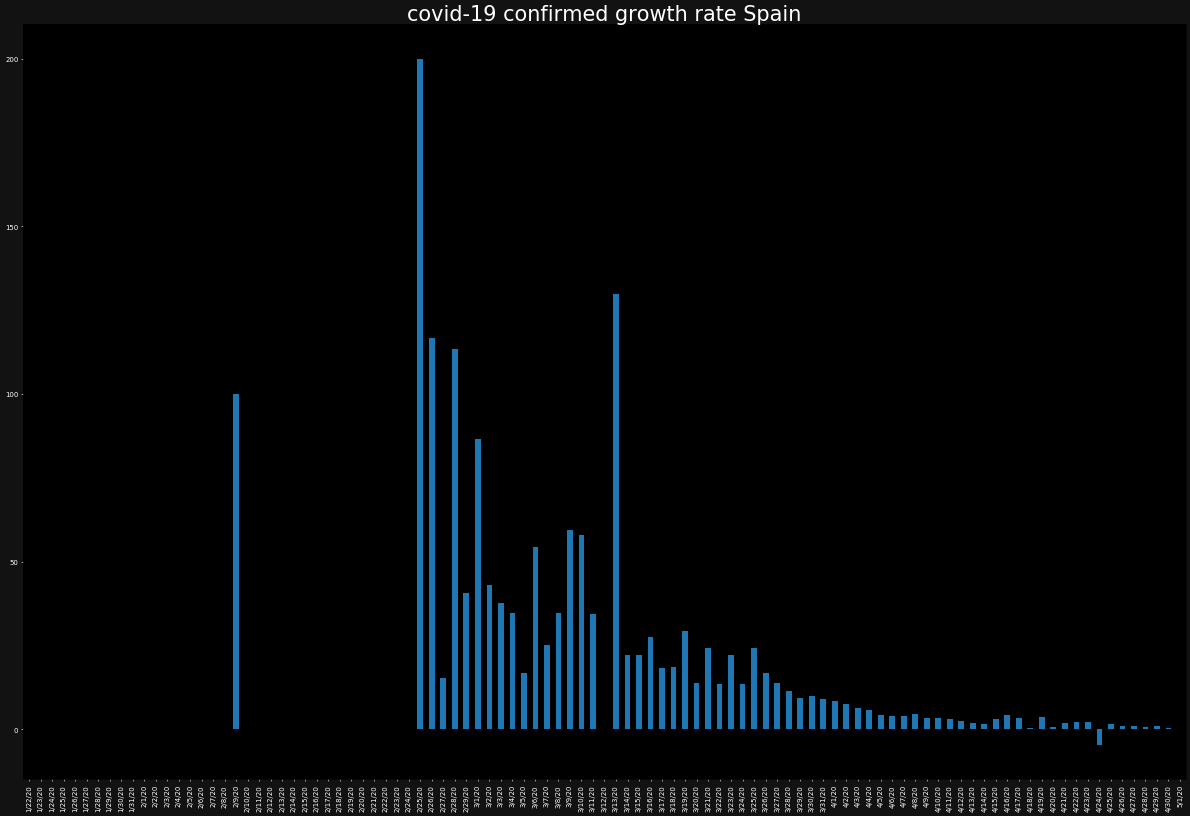

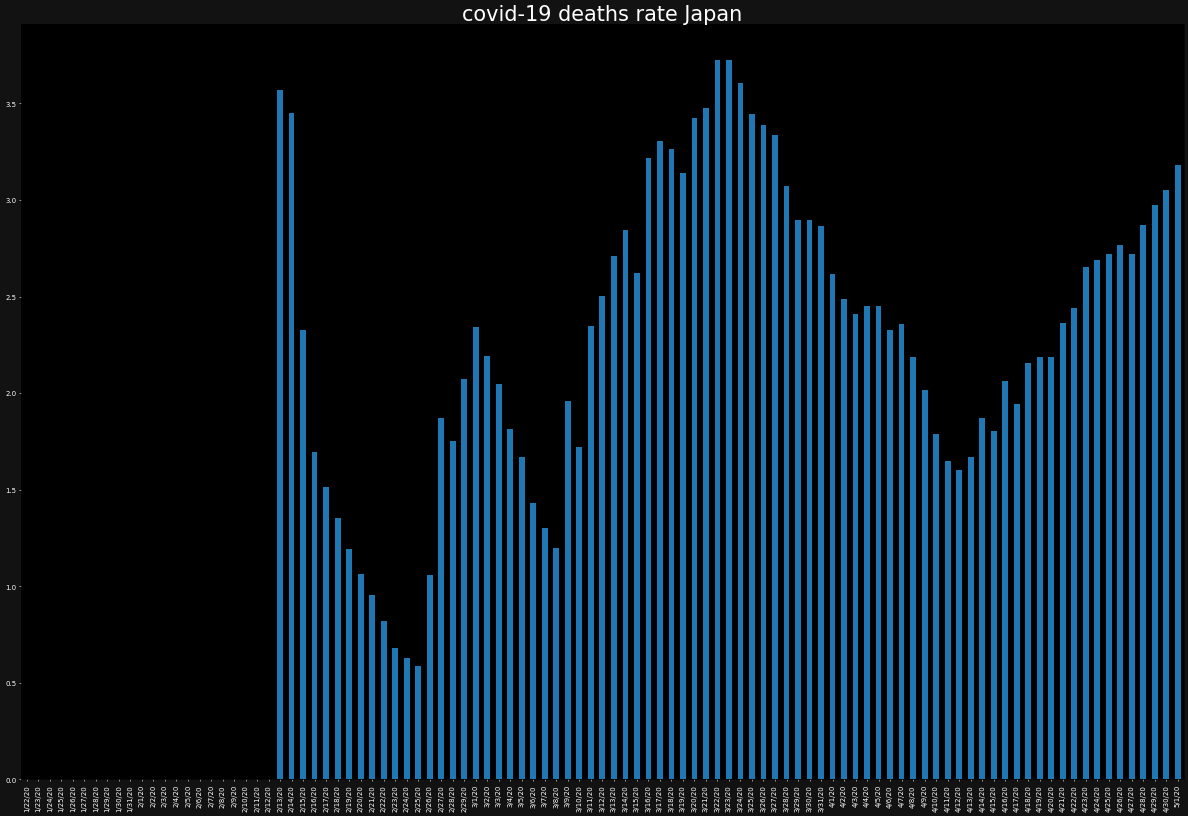

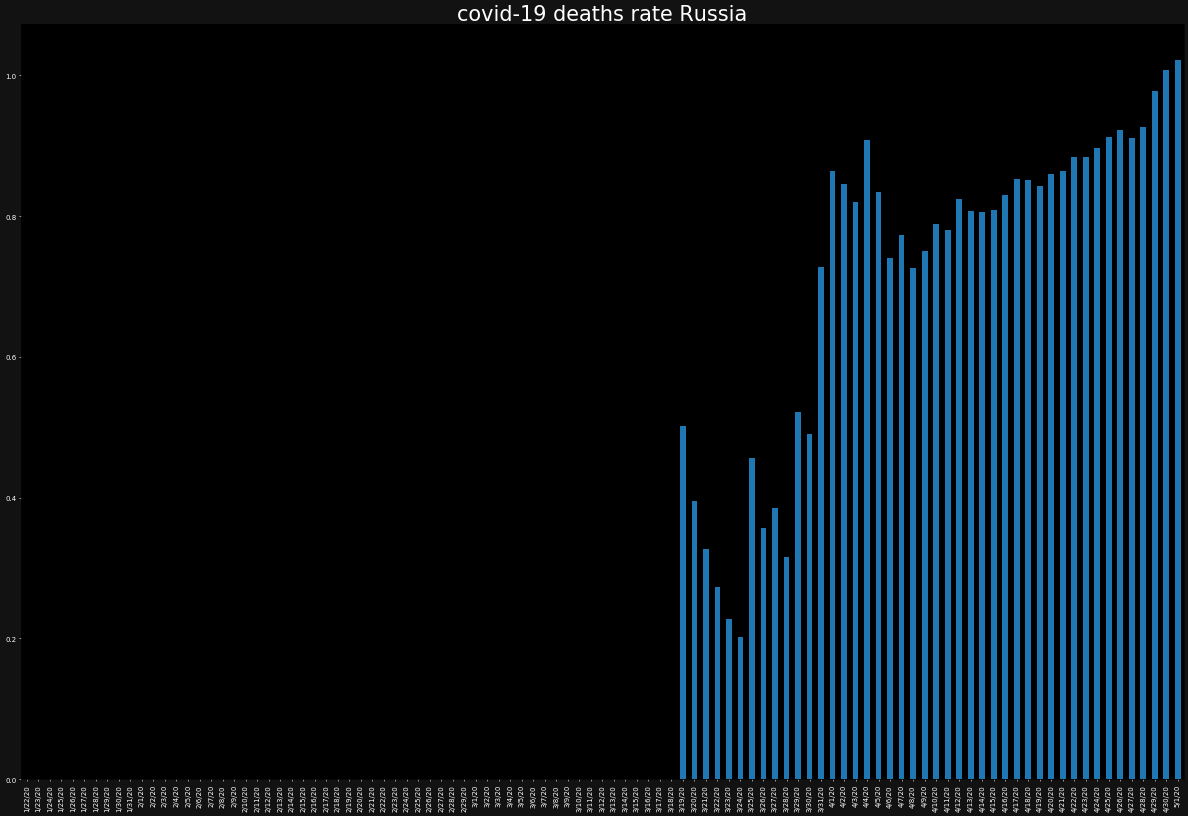

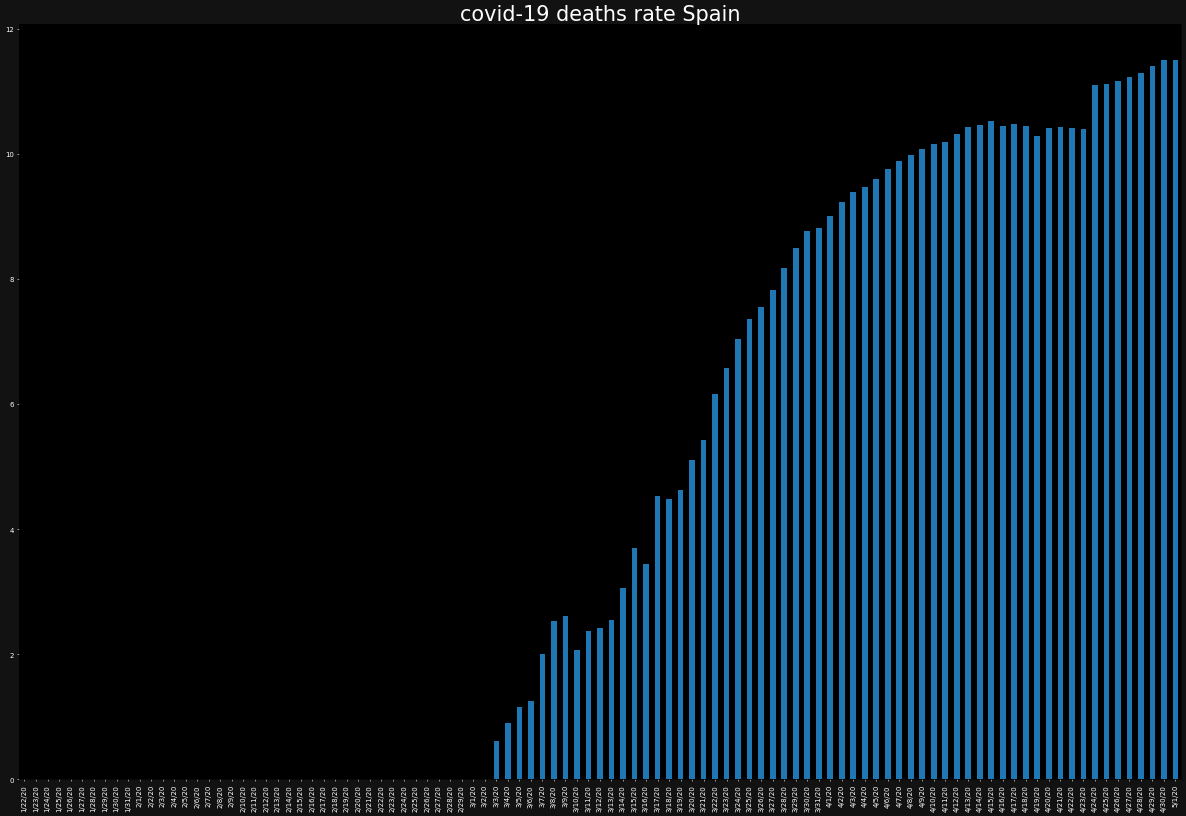

for country in countries: ax = plt.subplot() ax.set_facecolor("black") ax.figure.set_facecolor("#121212") ax.tick_params(axis="x",colors="white") ax.tick_params(axis="y",colors="white") ax.set_title(f"covid-19 confirmed growth rate {country}",color="white") growth_rate[country].plot.bar() plt.show()同じ要領で死者数の感染数、死亡率(※上記は、"感染者の増加率"でこちらは"死亡率"です)も見ましょう。

ax = plt.subplot() ax.set_facecolor("black") ax.figure.set_facecolor("#121212") ax.tick_params(axis="x",colors="white") ax.tick_params(axis="y",colors="white") ax.set_title("covid-19 deaths by countries",color="white") for country in countries: deaths[country].plot(label=country) plt.legend(loc="upper left") plt.show()for country in countries: ax = plt.subplot() ax.set_facecolor("black") ax.figure.set_facecolor("#121212") ax.tick_params(axis="x",colors="white") ax.tick_params(axis="y",colors="white") ax.set_title(f"covid-19 deaths rate {country}",color="white") death_rate[country].plot.bar() plt.show()死亡率に国別で差があることが分かります。

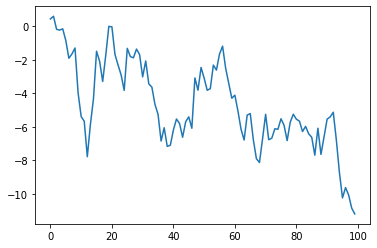

さて、最後に今後のコロナウイルスの影響のシミュレーションに移ります。

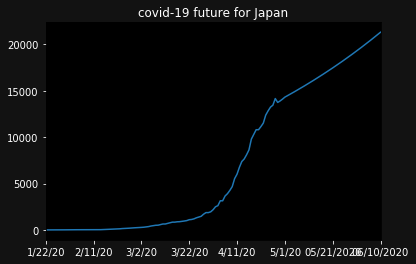

一旦、今後、仮値として、日次で1%の感染者が増えるとしましょう。simulated_growth_rate = 0.01ここで、予測用のこれからの新しい日付データを追加します。

範囲を指定して、日付データを生成できるdate_rangeメソッドを利用します。

今回用いているデータは、05/01/20が最後なので、その次の日から40日間。dates = pd.date_range(start="05/02/2020",periods=40,freq='D') dates = pd.Series(dates) dates = dates.dt.strftime("%m/%d/%Y")simulated = confirmed.copy() simulated = simulated.append(pd.DataFrame(index=dates)) for day in range(len(confirmed),len(confirmed)+40): simulated.iloc[day] = simulated.iloc[day-1] * (1 + simulated_growth_rate) ax = plt.subplot() ax.set_facecolor("black") ax.figure.set_facecolor("#121212") ax.tick_params(axis="x",colors="white") ax.tick_params(axis="y",colors="white") ax.set_title(f"covid-19 future for Japan",color="white") simulated['Japan'].plot() plt.show()※ 念押しですが、これは仮の成長率(※ 日次1%ずつ増え続ける)に基づいた数字です。厳密なシミュレーションとして、受け止める必要はありません。

以上です。ちょくちょく引用元の動画と違う部分はありますが、ざっとデータ分析の流れをつかめたかと思います。

是非、元動画をご覧ください。

投稿者のNeuralNine氏は、動画の最後に、この分析は仮の数値などはあるものだから、真剣に受け止めなくていいことは強調したうえで、事実をデータをもとに把握し、自分が意識すべきことは大事であることを伝えてくれていました。

- 投稿日:2020-05-15T20:43:39+09:00

【強化学習】R2D2を実装/解説してみたリベンジ ハイパーパラメータ解説編(Keras-RL)

ハイパーパラメータ解説編です。

各パラメータに関してまとめてみました。中身のアルゴリズムについてはこちら

【強化学習】R2D2を実装/解説してみたリベンジ 解説編(Keras-RL)コード全体

本記事の対象コードはgithubにあげています。

目次

- 共通パラメータ解説

- Rainbow/R2D2特有のパラメータ解説

- 学習以外の機能の解説

- NNモデルの中間層の可視化

- 動画化

- save/load

- 学習履歴のログ取得

- ハイパーパラメータ設定例

- DQN(論文)

- Keras-RL Cartpoleのサンプル

- Rainbow(論文)

- R2D2(論文)

共通パラメータ

Rainbow(DQN)とR2D2で共通のパラメータです。

env 依存関係のパラメータ

概要 型 例 備考 input_shape 入力shape tuple (84,84) env.observation_space.shape input_type 入力形式を指定 InputType InputType.GRAY_2ch 独自実装 image_model 画像層のモデル形式 ImageModel(独自実装) DQNImageModel() nb_actions アクション数(出力数) int 4 env.action_space.n processor Gymのカスタム機能を提供するクラス Processor(Keras-rl) None

input_shape

入力形式を tuple で指定します。

画像なら (width, height) の形式ですね。

Gym の場合は env.observation_space.shape で取得できる形式です。input_type

上記 input_shape を補う指定です。

独自実装しています。

下記の4つの種類を想定しており、input_shape の内容に合わせて指定してください。InputTypeclass InputType(enum.Enum): VALUES = 1 # 画像無し GRAY_2ch = 3 # (width, height) GRAY_3ch = 4 # (width, height, 1) COLOR = 5 # (width, height, ch)

image_model

前回の記事で解説した内容です。

ただ現状は2種類しかなく、画像じゃない場合は None、画像の場合は DQNImageModel() を指定してください。nb_actions

出力形式を int で指定します。

これは agent が選択できるアクション数に相当します。

例えば左と右と止まると3個操作方法がある場合は3アクションになります。

Gym の場合は env.action_space.n で取得できます。(Discrete形式のみ)processor

Gym で提供されている Env に対してカスタマイズ機能を提供するクラスです。(processor(Keras-rl公式))NN(ニューラルネットワーク)モデル関係のパラメータ

概要 型 例 備考 batch_size バッチサイズ int 32 optimizer 最適化アルゴリズム Optimizer(Keras) Adam(lr=0.0001) Keras実装 metrics 評価関数 array [] Keras実装 input_sequence 入力フレーム数 int 4 dense_units_num Dense層のユニット数 int 512 enable_dueling_network DuelingNetworkを使うかどうか bool True dueling_network_type DuelingNetworkで使うアルゴリズム DuelingNetwork DuelingNetwork.AVERAGE lstm_type LSTMを使用する場合の種類 LstmType(独自実装) LstmType.NONE lstm_units_num LSTM層のユニット数 int 512 lstm_ful_input_length 1学習あたりの入力学習回数 int 4 STATEFULの場合のみ使用

batch_size

ミニバッチ学習で使用する batch サイズです。(batchについてはこちら(Keras公式))

batchサイズを増やすと学習効率および学習速度が上がるという話があります。

ただ、強化学習は教師あり学習と違い、学習データに制限がないため batch サイズを増やすと学習コストが増える(1回の学習での収束速度は上がるが時間はかかるため、新しい経験を模索する回数が減る)ため、あまり増やしすぎない方がいい気もします。

また、batchサイズは 2^n を指定するといいとかなんとか。optimizer

NNモデルを compile する際に指定する Keras の Optimizer を指定します。

詳細はオプティマイザ(最適化アルゴリズム)の利用方法(Keras公式)等を参考にしてください。metrics

Keras の評価関数を指定します。使ったときないのであまり分からない…。

詳細は評価関数の利用方法(Keras公式)等を参考にしてください。input_sequence(以前はwindow_length)

入力に使う observation の数です。

1 で直近の1frameのみを入力とし、4だと直近から4frameまでを入力として使います。

この値を増やすと入力の表現力が増えますが、学習コストは増えます。dense_units_num

Dense層のユニット数です。

この値を増やすとNNの表現力が増えますが、学習コストは増えます。enable_dueling_network

DuelingNetworkを有効にするかどうかです。

DuelingNetworkは状態と行動を分けてNNに学習させることで学習効率をあげようというものです。dueling_network_type

DuelingNetwork で状態と行動を分ける時に使うアルゴリズムです。

以下の3種類から指定できます。

論文では Average が一番いい結果が出たと書いてありました。DuelingNetworkclass DuelingNetwork(enum.Enum): AVERAGE = 0 MAX = 1 NAIVE = 2

- lstm_type

LSTMを使う場合の種類を指定します。

LSTMを使用すると時系列に関する情報も学習する事が出来ますが学習コストは増えます。

使わない場合は NONE を指定してください。

STATELESS を指定するとDRQN相当のシンプルなLSTM層をNNモデルに追加します。

STATEFUL を指定するとR2D2相当の複雑な処理をするLSTM層をNNモデルに追加します。

STATEFULはSTATELESSに比べて学習効率は上がりますが、学習コストがかなり増えます。

LstmTypeclass LstmType(enum.Enum): NONE = 0 STATELESS = 1 STATEFUL = 2

- lstm_ful_input_length

STATEFULの学習における1学習あたりの入力学習回数です。

STATEFULで学習する場合、時系列に沿う形で学習回数を増やす事が出来ます。

その時系列に沿った学習回数の数をここで指定します。(詳細は前回の記事を参照)

数字を増やすと学習効率は(多分)上がりますが、学習コストが増えます。

Experience Replay Memory関連

概要 型 例 備考 memory/remote_memory 使用するメモリ Memory(独自実装) ReplayMemory(10000) 下記参照 経験を貯めるメモリの種類を指定します。

DQN では経験したデータは一度メモリに格納します。

その後、メモリの中からランダムに経験を取り出して学習を行います。

メモリから取り出す方法によっていくつか種類があるのでそれについて説明します。ReplayMemory

DQN で使われているシンプルなメモリです。(以前の記事)

経験データをランダムに取り出します。ReplayMemory( capacity=10_000 )

- capacity

メモリに保存する最大容量です。

多いほうがいいですが、多すぎるとPC側の物理メモリが圧迫されるのでほどほどに。PERGreedyMemory

優先順位付き経験再生における愚直な実装です。

ランダムではなくTD誤差が最大の経験(もっとも学習への反映率が高い)経験を取り出す方法です。

ただ、これはランダム要素がないのですぐ局所解に入る気がしてうまく学習できません…。(なぜ実装した)PERGreedyMemory( capacity=10_000 )

- capacity

メモリに保存する最大容量です。PERProportionalMemory

優先順位付き経験再生におけるProportional Prioritization(比例優先順位付け)のメモリです。

ランダムではなくTD誤差の確率分布にしたがって経験を取り出す方法です。

(TD誤差が多い経験ほど取り出される確率が高くなる)ReplayMemory(ランダム選択)よりはかなり学習効率が良くなる感じです。

PERGreedyMemory( capacity=100000, alpha=0.9, beta_initial, beta_steps, enable_is, )パラメータは後述します。

PERRankBaseMemory

優先順位付き経験再生におけるRankBase(順位優先付け)のメモリです。

ランダムではなくTD誤差の順位に比例して経験を取り出します。

例えば3つ経験がある場合、1位は50%、2位は33%、3位は17%で選択されるといった感じです。ReplayMemory(ランダム選択)よりはかなり学習効率が良くなる感じですが、

Proportional との違いはあまり分かりません。

速度的にはこちらの方が少しだけはやくなっているはず…。PERRankBaseMemory( capacity=100000, alpha=0.9, beta_initial, beta_steps, enable_is, )パラメータは後述します。

PERProportionalMemoryとPERRankBaseMemoryのパラメータ

概要 型 例 備考 capacity メモリに保存する最大容量 int 1_000_000 alpha 確率反映率 float 0.9 0.0~1.0 beta_initial IS反映率の初期値 float 0.0 0.0~1.0 beta_steps ISの反映率を1.0にするまでのstep数 int 100_000 学習回数に依存 enable_is ISを有効にするか bool True

capacity

メモリに保存する最大容量です。alpha

Priority/RankBase の反映率です。(0.0~1.0)

0.0で完全ランダム(ReplayMemoryと同様)で、1.0なら確率分布に完全に従います。ここで重要度サンプリング(IS)の説明をします。

確率分布に従って経験を出す場合、各経験が選ばれる回数に偏りが生じます。

経験の選択回数が偏ると学習にバイアスがかかってしまうので、それを回避するのが重要度サンプリングです。具体的には、高い確率で選ばれる経験はQ値の更新への反映率を低くし、低い確率で選ばれる経験はQ値の更新への反映率を高くするというものです。

ISを導入することで学習が安定するらしいです。

また、ISはアニーリング(徐々に反映していく)します。

beta_initial

ISの反映率の初期値です。(0.0 でISを使用しない状態、1.0でISを反映した状態)beta_steps

ISの反映率を1.0にするまでのstep数です。

学習回数を元に指定してください。enable_is

ISを有効にするかどうかです。学習関係のパラメータ

概要 型 例 備考 memory_warmup_size/ remote_memory_warmup_size メモリに経験が貯まるまで学習しないサイズ int 1000 target_model_update Targetモデルへの更新間隔 int 10000 gamma Q学習の割引率 float 0.99 0.0~1.0 enable_double_dqn DoubleDQNを使用するか bool True enable_rescaling rescaling関数を使用するか bool True rescaling_epsilon rescaling関数で使う定数 float 0.001 priority_exponent 経験の優先度を計算する際の比率 float 0.9 LESTFULのみ使用 burnin_length burn-inの期間 int 2 LESTFULのみ使用 reward_multisteps MultiStep Reward のstep数 int 3

memory_warmup_size / remote_memory_warmup_size

初期状態ではメモリに経験がなく、学習ができません。

ですのでメモリに経験が貯まるまで学習しない期間を作ります。

その期間をここで指定します。

batch_size 以上の値であまり少なすぎない値がいいと思います。

(あまり減らすと初期で偏った経験データがあった場合に局所解に陥る可能性があります)target_model_update

DQNにおけるTargetNetworkの更新間隔です。

DQNではTargetNetworkという更新専用のQネットワークを用いて更新します。

TargetNetworkは学習は行わず、一定間隔で今のQネットワークをコピーします。

こうすることで更新に使用するQネットワークに時差が生まれて更新が良くなるとのことです。gamma

Q学習の割引率です。

報酬をどれだけ伝搬させるかを指定します。

まあ、ほぼ1.0に近い値でいいと思います。enable_double_dqn

DoubleDQNは学習時に最大のQ値を選んで学習していましたが、ノイズ等の影響で過大評価されている可能性があり良くないということで提案された手法です。

DoubleDQNを使うと学習効率が上がる気がします。enable_rescaling

報酬に対してrescaling関数を使用するか指定します。

rescaling関数を使用すると報酬がある程度丸められるので報酬による学習のブレが抑えられます。rescaling_epsilon

rescaling関数で使う定数です。

0になるのを防ぐ定数のようでほぼ0に近い値ならいいかと思います。

(0.001は論文で使われている数字です)priority_exponent

R2D2相当のLSTM学習(LSTMFUL)で使っているPriority(経験の優先度)の計算で使用します。

LSTMFUL では複数の Priority を元に最終的な Priority(経験の優先度)を決定します。

その計算方法は $Priorityの最大値 + Priorityの平均値$ です。

この最大値と平均値をどれだけ反映させるかの割合が priority_exponent となります。

0.9 の場合は $Priorityの最大値*0.9 + Priorityの平均値*0.1$ となります。

論文では0.9ぐらいがいい結果になったと書いてありました。burnin_length

R2D2相当のLSTM学習(LSTMFUL)で使っているBurn-inの回数です。

ざっくりいうと、LSTMFULでは過去の状態(経験データ格納時)と現在の状態に差異があります。

ですので、学習前に今の状態に近づける為に学習しないで経験データを流す期間を設けましょうという手法です。

burnin_length を増やすと学習はより正確になりますが、学習コストが増えます。reward_multisteps

Multi-Step learningにおけるstep数となります。

通常は1step分の報酬を使うが、n-step分の報酬を使用するというもの。

感覚的には少し未来の報酬まで視野にいれて学習する感じですかね(?)

3stepは論文で使用している値です。アクション関係

概要 型 例 備考 action_interval アクション実行間隔 int 1 1以上 action_policy アクション実行で使用する方策 Policy(独自実装) 下記参照

action_interval

アクションの更新間隔です。

例えば4にすると4フレーム毎にアクションが更新されます。

(更新されない間は同じアクションを実行します)action_policy

アクションを実行する方策を指定します。

各方策の詳細については以前の記事を参照してください。ε-greedy

ε-greedyは乱数(0.0~1.0)に対して $epsilon$ 以下ならランダムに行動、

それより大きければQ値が最大となるアクションを選びます。EpsilonGreedy( epsilon )ε-greedy(Annealing)

DQNで使用された方法です。

ε-greedy における $epsilon$ を学習が進むにつれて低くする(Q値に従う)にする手法です。AnnealingEpsilonGreedy( initial_epsilon=1, final_epsilon=0.1, exploration_steps=1_000_000 )

initial_epsilon

初期 $epsilon$ です。final_epsilon

最終状態の $epsilon$ です。exploration_steps

初期から最終状態になるまでの step 数を指定します。ε-greedy(Actor)

Ape-Xで使用された方法です。

ε-greedy における $epsilon$ をActor数を基に計算したものとなります。EpsilonGreedyActor( actor_index, actors_length, epsilon=0.4, alpha=7 )

actor_index

actorのindexを指定します。actors_length

actorの総数です。epsilon

基準となる $epsilon$ を指定します。alpha

計算で使う定数です。Softmax

Q値のSoftmax関数の確率分布でアクションを決める方法です。

要するにQ値が高いアクションほど選ばれやすくなり、低いアクションほど選ばれにくくなります。SoftmaxPolicy()引数はありません。

UCB(Upper Confidence Bound)1

UCB1は、Q値だけではなくそのアクションが選ばれた回数も加味してアクションを選ぶ手法です。

考え方はあまり選んでいないアクションはあまり探索が進んでおらず未知の報酬があるかもしれないので探索しようというものです。UCB1()引数はありません。

また、内部にNNモデルを保持して学習しているので学習コストが増えます。UCB1-Tuned

UCB1-Tunedは、UCB1に分散も考慮して改良したアルゴリズムです。

UCB1より優れた結果を出しますが理論的な保証はないとの事です。UCB1_Tuned()引数はありません。

また、内部にNNモデルを保持して学習しているので学習コストが増えます。UCB-V

UCB1-Tunedより更に分散を意識したアルゴリズムです。

UCBv()引数はありません。

また、内部にNNモデルを保持して学習しているので学習コストが増えます。KL-UCB

探索と報酬のジレンマの理論上の最適値を求めたアルゴリズムです。

ただ、実装がちょっとおかしいかもしれません…。KL_UCB()引数はありません。

また、内部にNNモデルを保持して学習しているので学習コストが増えます。Thompson Sampling(ベータ分布)

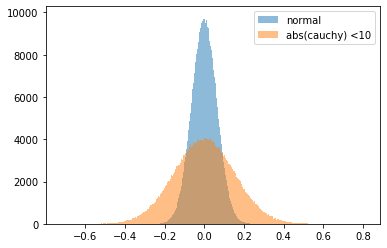

Thompson Sampling はベイス推定を元にしたアルゴリズムです。

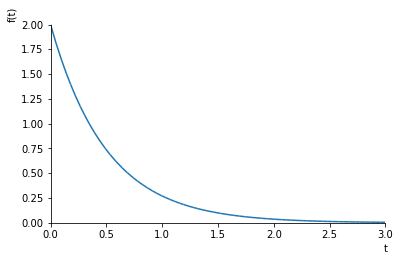

これも探索と報酬のジレンマの理論上の最適値になっています。ベータ分布は0か1の2値をとる場合に適用できる分布となります。

実装では報酬が0より大きい場合は1、0以下は0として扱っています。ThompsonSamplingBeta()引数はありません。

また、内部にNNモデルを保持して学習しているので学習コストが増えます。Thompson Sampling(正規分布)

Thompson Sampling はベイス推定を元にしたアルゴリズムです。

これも探索と報酬のジレンマの理論上の最適値になっています。報酬が正規分布に従うと仮定してアルゴリズムを適用しています。

ThompsonSamplingGaussian()引数はありません。

また、内部にNNモデルを保持して学習しているので学習コストが増えます。Rainbow(DQN)のみ関連

概要 型 例 備考 train_interval 学習の間隔 int 1 1以上 train_interval を増やすことで学習の間隔をあける事が出来ます。

R2D2のみ関連

概要 型 例 備考 actors Actorクラスを指定 Actor(独自実装) 下記参照 actor_model_sync_interval LearnerからNNモデルを同期する間隔 int 500

- actor_model_sync_interval

LearnerからActorに対してNNモデルを同期する間隔です。

数字は Learner の学習回数に対応しています。Actor

独自実装で、Actor を表現するクラスとなります。

これを継承し、各Actorが実行する Policy と env.fit を定義します。定義例です。

from src.r2d2 import Actor from src.policy import EpsilonGreedy ENV_NAME = "xxx" class MyActor(Actor): def getPolicy(self, actor_index, actor_num): return EpsilonGreedy(0.1) def fit(self, index, agent): env = gym.make(ENV_NAME) agent.fit(env, visualize=False, verbose=0) env.close()getPolicy でそのActorが使用するアクションポリシーを指定します。

fit 内で引数にある agetn に fit を実行させ学習させます。R2D2に渡すときに気を付ける点ですが、クラス自体を渡して下さい(インスタンス化しないでください)

from src.r2d2 import R2D2 kwargs = { "actors": [MyActor] # クラス自体を渡す (省略) } manager = R2D2(**kwargs)Actorを増やす場合は配列の要素数を増やせば増えます。

Actor4人の例from src.r2d2 import R2D2 kwargs = { "actors": [MyActor, MyActor, MyActor, MyActor] (省略) } manager = R2D2(**kwargs)その他

MovieLogger(Rainbow/R2D2)

動画を出力するCallbackです。

Rainbow及びR2D2両方で使えます。from src.callbacks import MovieLogger # test の callcacks引数に追加してください。 movie = MovieLogger() agent.test(env, nb_episodes=1, visualize=False, callbacks=[movie]) # 保存します。 movie.save( start_frame=0, end_frame=0, gifname="pendulum.gif", mp4name="", interval=200, fps=30 ):

start_frame

開始フレームを指定します。end_frame

終了フレームを指定します。

0なら終わりまですべてのフレームが対象になります。gifname

gif形式で出力する場合のpathです。

matplotlibのアニメーションで保存します。

"" なら出力しません。mp4name

mp4形式で出力する場合のpathです。

matplotlibのアニメーションで保存します。

"" なら出力しません。interval

matplotlibのFuncAnimationに渡すintervalです。fps

matplotlibで動画を保存する際のfpsです。NNの中間層可視化(Rainbow/R2D2)

以前の記事で紹介したConv層およびAdvance層、Value層可視化のCallbackです。

Rainbow及びR2D2両方で使えます。from src.callbacks import ConvLayerView # 初期化で agent を指定します。 conv = ConvLayerView(agent) # test を実施します。 # callbacks 引数に ConvLayerViewオブジェクトを指定 agent.test(env, nb_episodes=1, visualize=False, callbacks=[conv]) # 結果を保存します。 conv.save( grad_cam_layers=["conv_1", "conv_2", "conv_3"], add_adv_layer=True, add_val_layer=True, start_frame=0, end_frame=200, gifname="tmp/pendulum.gif", interval=200, fps=10, )

grad_cam_layers

対象のConv層を指定します。

名前はImageModel内で指定した名前となります。add_adv_layer

Advance層を追加するかadd_val_layer

Value層を追加するかstart_frame

開始フレームを指定します。end_frame

終了フレームを指定します。

0なら終わりまですべてのフレームが対象になります。gifname

gif形式で出力する場合のpathです。

matplotlibのアニメーションで保存します。

"" なら出力しません。mp4name

mp4形式で出力する場合のpathです。

matplotlibのアニメーションで保存します。

"" なら出力しません。interval

matplotlibのFuncAnimationに渡すintervalです。fps

matplotlibで動画を保存する際のfpsです。また、ConvLayerView は入力が画像(InputTypeが GRAY_2ch, GRAY_3ch, COLOR)のいずれかの場合のみ動作します。

Logger2Stage(Rainbow)

以下2つの機能を提供します。

- 2段階に分けてログ取得間隔を設定

- ログ取得に当たってtest環境(学習環境ではなくQ値の最大値で動作)を使用

from src.rainbow import Rainbow from src.callbacks import Logger2Stage # テスト用の agent と env を別途作成します kwargs = (省略) test_agent = Rainbow(**kwargs) test_env = gym.make(ENV_NAME) # 各種設定 log = Logger2Stage( logger_type=LoggerType.STEP, warmup=1000, interval1=200, interval2=20_000, change_count=5, savefile="tmp/log.json", test_agent=test_agent, test_env=test_env, test_episodes=10 ) # 学習時の callbacks に追加します # Logger2Stageがログを出力するので verbose=0 としています agent.fit(env, nb_steps=1_750_000, visualize=False, verbose=0, callbacks=[log]) # getLogs関数でログを取得できます(savefileを指定する必要があります) history = log.getLogs() # 簡易ですが、グラフの出力もできます(savefileを指定する必要があります) log.drawGraph()

logger_type

ログの記録形式です。

LoggerType.TIME:時間で取得します。

LoggerType.STEP:step数で取得します。warmup

最初の warmup 時間はログ取得をしません。

LoggerType.TIME なら秒、LoggerType.STEPならstep数になります。interval1

最初のログ取得間隔です。

LoggerType.TIME なら秒、LoggerType.STEPならstep数になります。interval2

2段階目のログ取得間隔です。

LoggerType.TIME なら秒、LoggerType.STEPならstep数になります。change_count

1段階目から2段階目に移行する回数です。

1段階目がこの回数ログを取得したら2段階目に移ります。savefile

ログを保存するファイルです。test_agent

学習環境とは別にテストしたい場合は指定してください。

None だと学習環境の結果のみ出力します。test_env

学習環境とは別にテストしたい場合は指定してください。

None だと学習環境の結果のみ出力します。test_episodes

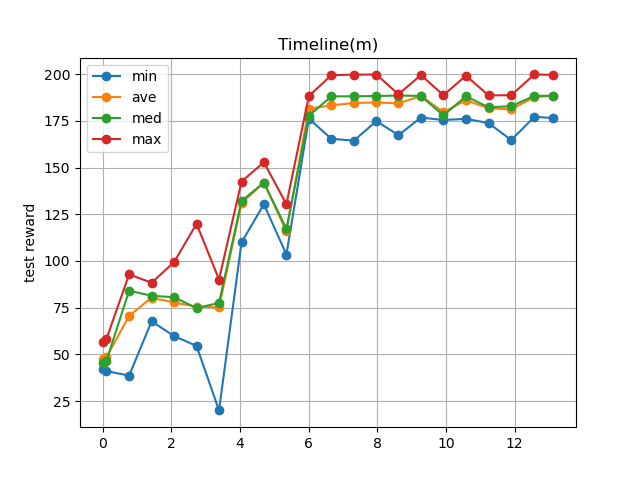

テスト環境でのepisode数です。・出力例

--- start --- 'Ctrl + C' is stop. Steps 0, Time: 0.00m, TestReward: 21.12 - 92.80 (ave: 51.73, med: 46.99), Reward: 0.00 - 0.00 (ave: 0.00, med: 0.00) Steps 200, Time: 0.05m, TestReward: 22.06 - 99.94 (ave: 43.85, med: 31.24), Reward: 108.30 - 108.30 (ave: 108.30, med: 108.30) Steps 1200, Time: 0.28m, TestReward: 40.99 - 73.88 (ave: 52.41, med: 47.69), Reward: 49.05 - 141.53 (ave: 87.85, med: 90.89) (省略) Steps 17200, Time: 3.95m, TestReward: 167.68 - 199.49 (ave: 184.34, med: 188.30), Reward: 166.29 - 199.66 (ave: 181.79, med: 177.36) Steps 18200, Time: 4.19m, TestReward: 165.84 - 199.53 (ave: 186.16, med: 188.50), Reward: 188.00 - 199.50 (ave: 190.64, med: 188.41) Steps 19200, Time: 4.43m, TestReward: 163.63 - 188.93 (ave: 186.15, med: 188.59), Reward: 165.56 - 188.45 (ave: 183.75, med: 188.23) done, took 4.626 minutes Steps 0, Time: 4.63m, TestReward: 188.37 - 199.66 (ave: 190.83, med: 188.68), Reward: 188.34 - 188.83 (ave: 188.63, med: 188.67)SaveManager(R2D2)

R2D2 はmultiprocessingを使用しており実装の方法がかなり特殊です。

特にモデルのsave/loadにはかなり影響が出たので別途用意しました。from src.r2d2 import R2D2 from src.r2d2_callbacks import SaveManager # R2D2 の作成 kwargs = (省略) manager = R2D2(**kwargs) # SaveManagerの作成 save_manager = SaveManager( save_dirpath="tmp", is_load=False, save_overwrite=True, save_memory=True, checkpoint=True, checkpoint_interval=2000, verbose=0 ) # 学習開始、callbacks引数に追加する。 manager.train( nb_trains=20_000, callbacks=[save_manager], ) # test用のAgentを作成する場合は以下を呼ぶ # save_dirpath/last/learner.dat を指定してください。 agent = manager.createTestAgent(MyActor, "tmp/last/learner.dat") # testを実施。 agent.test(env, nb_episodes=5, visualize=True)

save_dirpath

結果を保存するディレクトリです。

ディレクトリ配下にチェックポイント用のディレクトリをさらに作るのでディレクトリ形式にしています。is_load

以前の学習結果をloadするかどうかsave_overwrite

保存結果を上書きするかどうかsave_memory

ReplyMemoryの中身も保存するか。

保存すると前回と全く同じ状況から学習を再開可能ですけどメモリのファイルサイズが大きいです(数GB程度)。

また、.mem ファイルで別保存されているので後から削除可能です。checkpoint

途中経過を保存するかどうかcheckpoint_interval

途中経過を保存する場合のintervalです。

単位はLearnerの学習回数となります。verbose

0の場合はprint出力しません。

1の場合はprint出力があります。Logger2Stage(R2D2)

以下2つの機能を提供します。

- 2段階に分けてログ取得間隔を設定

- ログ取得に当たってtest環境(学習環境ではなくQ値の最大値で動作)を使用

また、rainbowと違って、時間での取得間隔しかありません。

from src.r2d2 import R2D2 from src.r2d2_callbacks import Logger2Stage # R2D2 の作成 kwargs = (省略) manager = R2D2(**kwargs) # テスト用のenvを作成 test_env = gym.make(ENV_NAME) # Logger2Stageを作成 log = Logger2Stage( warmup=0, interval1=10, interval2=60, change_count=20, savedir="tmp", test_actor=MyActor, test_env=test_env, test_episodes=10, verbose=1, ) # 学習開始、callbacks引数に追加する。 manager.train( nb_trains=20_000, callbacks=[log], ) # getLogsでログを取得できます。(savedirを指定している場合) history = log.getLogs() # 簡易にグラフ表示もできます。(savedirを指定している場合) log.drawGraph()

warmup

最初に取得を始めるまでの時間です。(秒)interval1

最初のログ取得間隔です。(秒)interval2

2段階目のログ取得間隔です。(秒)change_count

1段階目から2段階目に移行する回数です。

1段階目がこの回数ログを取得したら2段階目に移ります。savedir

ログを保存するディレクトリです。

LearnerとActorでプロセスが分かれており、各プロセスが値を保存するために競合を避けるためファイルを分けています。test_actor

テスト時に使用するActorクラスを指定します。

None だとテストは実施しません。test_env

学習環境とは別にテストしたい場合は指定してください。

None だとテストは実施しません。test_episodes

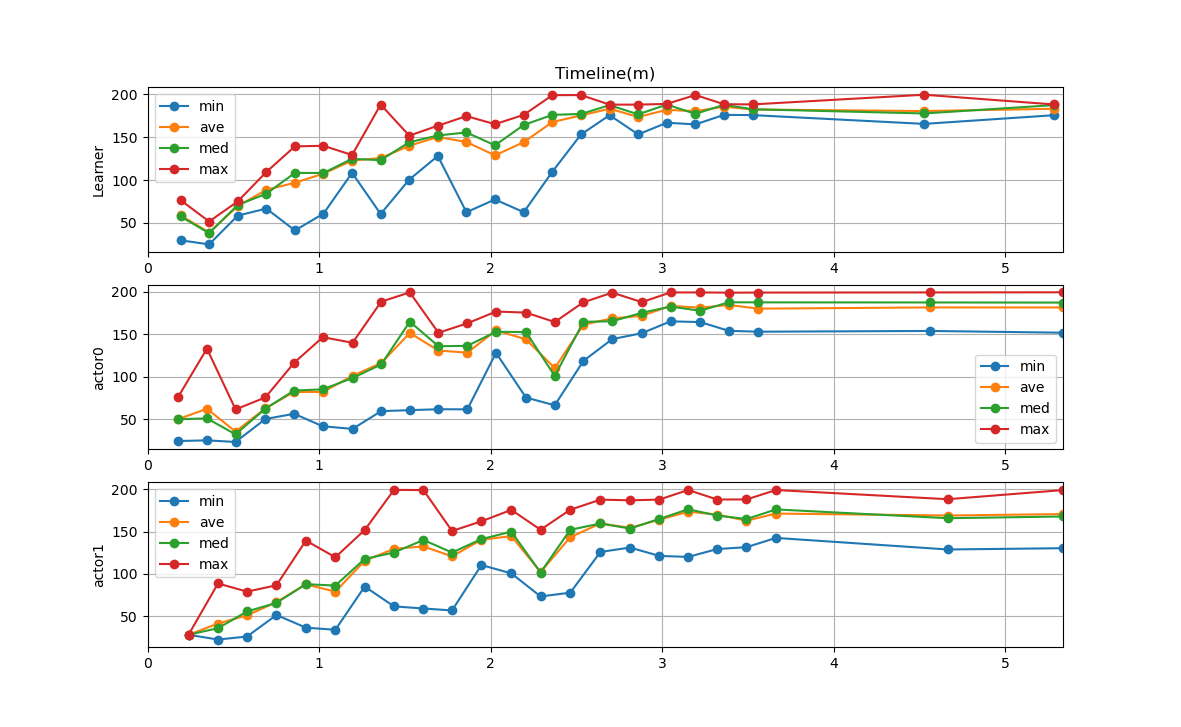

テスト環境でのepisode数です。・出力例

--- start --- 'Ctrl + C' is stop. Learner Start! Actor0 Start! Actor1 Start! actor1 Train 1, Time: 0.24m, Reward : 27.80 - 27.80 (ave: 27.80, med: 27.80), nb_steps: 200 learner Train 1, Time: 0.19m, TestReward: 29.79 - 76.71 (ave: 58.99, med: 57.61) actor0 Train 575, Time: 0.35m, Reward : 24.88 - 133.09 (ave: 62.14, med: 50.83), nb_steps: 3400 learner Train 651, Time: 0.36m, TestReward: 24.98 - 51.67 (ave: 38.86, med: 38.11) actor1 Train 651, Time: 0.41m, Reward : 22.15 - 88.59 (ave: 41.14, med: 35.62), nb_steps: 3200 actor0 Train 1249, Time: 0.51m, Reward : 22.97 - 61.41 (ave: 35.24, med: 31.99), nb_steps: 8000 (省略) learner Train 16476, Time: 4.53m, TestReward: 165.56 - 199.57 (ave: 180.52, med: 177.73) actor1 Train 16880, Time: 4.67m, Reward : 128.88 - 188.45 (ave: 169.13, med: 165.94), nb_steps: 117600 Learning End. Train Count:20001 learner Train 20001, Time: 5.29m, TestReward: 175.72 - 188.17 (ave: 183.21, med: 187.48) Actor0 End! Actor1 End! actor0 Train 20001, Time: 5.34m, Reward : 151.92 - 199.61 (ave: 181.68, med: 187.48), nb_steps: 0 actor1 Train 20001, Time: 5.34m, Reward : 130.39 - 199.26 (ave: 170.83, med: 167.99), nb_steps: 0 done, took 5.350 minutes設定値サンプル

DQNの論文(Atari)