- 投稿日:2019-11-12T23:54:22+09:00

PandasのDataFrameに対する基本操作をJupyter Notebook上で試す

いままでPythonでPandasでのデータ操作は、必要になったらググって使い方を調べればいいという程度のスタンスでしたが、データ分析や機械学習のあたりを勉強するにあたって、Jupyter Notebookでデータをスラスラと操作できないと話にならないと感じてきて、Pandasの使い方を基本から改めて整理して勉強し始めています。この記事はその勉強ノートです。

DataFrameの概要

PandasのDataFrameは、行と列のある表形式のデータのイメージです。行には0から始まる行番号を付けることもありますが、文字列でもいいようです。列には列の名前がついています。

DataFrameは表形式であるのに対して、Seriesという列だけのオブジェクトもあります。

DataFrameとSeriesの内容は以下の記事がとても参考になりました。

僕のpandas.SeriesとDataFrameのイメージは間違っていた - Qiitaこの記事の内容は、以下のリンク先に従って準備したJupyter Notebookの環境で試しています。

Jupyter NotebookをDockerを使って簡単にインストールし起動(nbextensions、Scalaにも対応) - Qiitaこの環境でブラウザで8888番ポートにアクセスして、Jupyter Notebookを使うことができます。右上のボタンのNew > Python3をたどると新しいノートを開けます。

Pythonパッケージインポート

import pandas as pdCSVファイルから読み込む

# ヘッダーがある場合 df = pd.read_csv("data.csv") # ヘッダー行が列名になる # ヘッダーがない場合 df = pd.read_csv("data.csv", header=None) # 0から始まる番号が列名になる # ヘッダーがなく列名を指定したい場合 df = pd.read_csv("data.csv", names=["id", "target", "data1", "data2", "data3"])この記事のこれ以降は、適当な乱数で作成したCSVファイル

https://github.com/suzuki-navi/sample-data/blob/master/sample-data-1.csv

を使っています。(GitHubってCSVファイルも整形して表示してくれるんですね)

データの内容を確認

DataFrameのオブジェクトはJupyter Notebook上で内容を簡単に確認できます。

データの一部だけを見たい場合

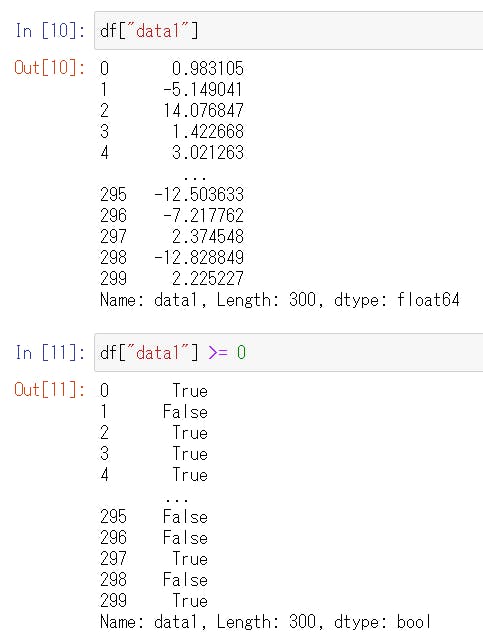

# 先頭の5行 df.head() # 先頭の3行 df.head(3) # or df[:3] # 最後の5行 df.tail() # 最後の3行 df.tail(3) # 11行目から20行目だけを抜き出す # (0から始まるインデックスでいうと10から19) df[10:20] # 11行目から最後までを抜き出す # (0から始まるインデックスでいうと10から後ろ) df[10:] # 11行目のみを確認 # (0から始まるインデックスでいうと10) df.loc[10] # 特定の列のみを抜き出す df[["target", "data1"]] # 特定の列のみを抜き出す # DataFrameでなくSeriesになる df["data1"] # df[["data1"]]とは異なる # 特定の行範囲の特定の列のみを抜き出す df[["target", "data1"]][10:20] # or df[10:20][["target", "data1"]]一部の行のみを抜き出しても、行についているインデックスは維持されます。

データの形式を確認

df.shape # => (300, 5) df.columns # => Index(['id', 'target', 'data1', 'data2', 'data3'], dtype='object') df.dtypes # => id int64 # target int64 # data1 float64 # data2 float64 # data3 float64 # dtype: object列に対して演算

列に対して演算ができます。

df["data1"]はSeriesですが、df["data1"] / 100のように書くとSeriesの各要素に対して/ 100という演算をして、結果をSeriesで取得できます。列同士の演算もできます。

df["data1"] + df["data2"]行を条件で抽出

# df["data1"] >= 0 がTrueとなる行のみからなるDataFrameを生成 # 行のインデックスは維持されるので、とびとびの番号になる df[df["data1"] >= 0] # SQLみたいにクエリすることもできる df.query('data1 >= 30 and target == 1') # クエリの中に文字列を入れたい場合は "" で囲む df.query('target == "1"')重複を削除した値の一覧を取得

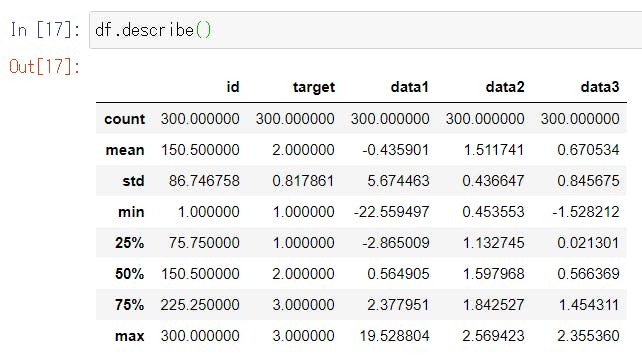

df["target"].unique() # => array([3, 2, 1])数値の列についての統計量を取得

df.describe()ソート

以下は、

data1列で行を並び替えたDataFrameを返します。# data1列の昇順 df.sort_values("data1") # data1列の降順 df.sort_values("data1", ascending=False) # 複数の列で並び替え df.sort_values(["target", "data1"], ascending=False)第1ソートを

target降順、第2ソートをdata1昇順とするにはどうしたらいいんだろう?列を追加

以下の例では、既存の列に演算を施した新しい値の列を右端に追加する。

df["data_sum"] = df["data1"] + df["data2"] + df["data3"]以上。

- 投稿日:2019-11-12T23:44:38+09:00

動画からキャプチャ画像を撮る方法(OpenCV)

きっかけ

OpenCVを使って長い動画を一部だけ保存する方法で取得した1分動画から画像処理のサンプル画像用に好きなところでキャプチャを撮るスクリプトを作ってみたっす

開発

Viewを表示して キーボードの s[save] ボタンを押すとキャプチャが保存されます。

import cv2 if __name__ == '__main__': cap = cv2.VideoCapture('one_minutes.mp4') window_name = "Drop Out NHK" save_press_count = 1 while True: presskey = cv2.waitKey(1) if not cap.isOpened(): break ret, frame = cap.read() if presskey == ord('q'): break elif presskey == ord('s'): cv2.imwrite("capture_{}.png".format(save_press_count), frame) # capture ボタンを押しただけ 画像を保存 save_press_count += 1 cv2.imshow(window_name,frame) cap.release() cv2.destroyWindow(window_name)結果

おわりに

OpenCV 2 プログラミングブック にあったコードを思い出して C++ -> Python に書き換えただけです。

処理用に複数枚の画像が欲しかっただけです。参考にしたリンク

- 投稿日:2019-11-12T22:42:28+09:00

PyTorchのBidirectional LSTMのoutputの仕様を確認してみた

はじめに

LSTMのリファレンスにあるように、PyTorchでBidirectional LSTMを扱うときはLSTMを宣言する際に

bidrectional=Trueを指定するだけでOKと、(KerasならBidrectionalでLSTMを囲むだけでOK)とても簡単に扱うことができます。

が、リファレンスを見てもLSTMをBidirectionalにしたきの出力についてはあまり触れられていないように思います。

ぱっとググってみてもPyTorchにおけるBidirectional LSTMの出力の仕様がいまいちよくわからなかったので、ここに簡単にまとめておきます。参考

- Bidirectional recurrent neural networks

- Understanding Bidirectional RNN in PyTorch

- Bidirectional LSTM output question in PyTorch

- わかるLSTM ~ 最近の動向と共に

仕様確認

参考1.や2.を見るとわかるように双方向のRNNやLSTMは前方向と後ろ方向のRNNやLSTMが重なっただけと至ってシンプルであることがわかるかと思います。

とりあえず実際に使ってみます。

import torch import torch.nn as nn # 各系列の埋め込み次元数を5 # LSTM層の隠れ層のサイズは6 # batch_first=Trueでインプットの形式を(batch_size, vocab_size, embedding_dim)にしてる # bidrectional=Trueで双方向LSTMを宣言 bilstm = nn.LSTM(5, 6, batch_first=True, bidrectional=True) # バッチサイズを1 # 系列の長さは4 # 各系列の埋め込み次元数は5 # であるようなtensorを生成する a = torch.rand(1, 4, 5) print(a) #tensor([[[0.1360, 0.4574, 0.4842, 0.6409, 0.1980], # [0.0364, 0.4133, 0.0836, 0.2871, 0.3542], # [0.7796, 0.7209, 0.1754, 0.0147, 0.6572], # [0.1504, 0.1003, 0.6787, 0.1602, 0.6571]]]) # 通常のLSTMと同様に出力は2つあるので両方受け取る out, hc = bilstm(a) print(out) #tensor([[[-0.0611, 0.0054, -0.0828, 0.0416, -0.0570, -0.1117, 0.0902, -0.0747, -0.0215, -0.1434, -0.2318, 0.0783], # [-0.1194, -0.0127, -0.2058, 0.1152, -0.1627, -0.2206, 0.0747, -0.0210, 0.0307, -0.0708, -0.2458, 0.1627], # [-0.0163, -0.0568, -0.0266, 0.0878, -0.1461, -0.1745, 0.1097, 0.0230, 0.0353, -0.0739, -0.2186, 0.0818], # [-0.1145, -0.0460, -0.0732, 0.0950, -0.1765, -0.2599, 0.0063, 0.0143, 0.0124, 0.0089, -0.1188, 0.0996]]], # grad_fn=<TransposeBackward0>) print(hc) #(tensor([[[-0.1145, -0.0460, -0.0732, 0.0950, -0.1765, -0.2599]], # [[ 0.0902, -0.0747, -0.0215, -0.1434, -0.2318, 0.0783]]], # grad_fn=<StackBackward>), #tensor([[[-0.2424, -0.1340, -0.1559, 0.3499, -0.3792, -0.5514]], # [[ 0.1876, -0.1413, -0.0384, -0.2345, -0.4982, 0.1573]]], # grad_fn=<StackBackward>))通常のLSTMと同様に出力は

outとhcと2つあって、hcのほうは通常のLSTMと同様にhc=(h,c)とタプル形式で返ってきます。通常のLSTMの出力と違う点は以下の2つかと思います。

outの各要素の次元がLSTMの隠れ層の次元のサイズ(今回は6)ではなく、その倍の値(今回であれば12)になっているhcの各要素hやcが2つ返ってきているこれらがどういうことかについて、ずばり図で説明すると以下の通りです。

(

cは省略してます。Embedding層も書いちゃったけど、Embedding層はLSTMでやってないです。)上の図からわかるように

outの各要素は前方向と後ろ方向の各隠れ層ベクトルを結合しています。(なので各要素の次元が通常の2倍になってる。)

また、hc=(h,c)のhは前方向と後ろ方向のそれぞれの最後の隠れ層ベクトルを返しています。つまり、

outの最後の要素の前半分はhc=(h,c)としたときのh[0]と一致outの最初の要素の後ろ半分はhc=(h,c)としたときのh[1]と一致することになります。上のサンプルのソースコードの出力からそれが読み取れますが、つまりはこういうこと。

print(out[:,-1][:,:6]) # outの最後の要素の前半分 print(hc[0][0]) # 前方向LSTMの最後の隠れ層の値 #tensor([[-0.1145, -0.0460, -0.0732, 0.0950, -0.1765, -0.2599]], grad_fn=<SliceBackward>) #tensor([[-0.1145, -0.0460, -0.0732, 0.0950, -0.1765, -0.2599]], grad_fn=<SelectBackward>) print(out[:,0][:,6:]) # outの最初の要素の後ろ半分 print(hc[0][1]) # 後ろ方向LSTMの最後の隠れ層の値 #tensor([[ 0.0902, -0.0747, -0.0215, -0.1434, -0.2318, 0.0783]], grad_fn=<SliceBackward>) #tensor([[ 0.0902, -0.0747, -0.0215, -0.1434, -0.2318, 0.0783]], grad_fn=<SelectBackward>)出力の仕様がわかったらあとはお好きなように料理すればよいですが、

文章分類のようなMany to OneのモデルをBidirectional LSTMにする際はLSTMの第2戻り値を結合したり、平均とったり、要素積をとったりといろいろ方法があるようです。

Kerasの場合なんかは(デフォルトでは)Keras側で結合してくれるようですが、PyTorchの場合はこれらの処理は自前で実装する必要があると思われます。

例えば私が過去に投稿したLSTMによる文章分類をBidirectional LSTMにする場合は以下のような感じになります。class LSTMClassifier(nn.Module): def __init__(self, embedding_dim, hidden_dim, vocab_size, tagset_size, batch_size=100): super(LSTMClassifier, self).__init__() self.batch_size = batch_size self.hidden_dim = hidden_dim self.word_embeddings = nn.Embedding(vocab_size, embedding_dim, padding_idx=0) self.bilstm = nn.LSTM(embedding_dim, hidden_dim, batch_first=True, bidirectional=True) # 前方向と後ろ方向の最後の隠れ層ベクトルを結合したものを受け取るので、hidden_dimを2倍している self.hidden2tag = nn.Linear(hidden_dim * 2, tagset_size) self.softmax = nn.LogSoftmax() def forward(self, sentence): embeds = self.word_embeddings(sentence) _, bilstm_hc = self.bilstm(embeds) # bilstm_out[0][0]->前方向LSTMの最後の隠れ層ベクトル # bilstm_out[0][1]->後ろ方向LSTMの最後の隠れ層ベクトル bilstm_out = torch.cat([bilstm_hc[0][0], bilstm_hc[0][1]], dim=1) tag_space = self.hidden2tag(bilstm_out) tag_scores = self.softmax(tag_space.squeeze()) return tag_scoresおわりに

- 世間的にはこんなことすぐにわかりそうな話なのかもしれませんが、自分みたいにPyTorchでBidirectional LSTMを扱うときに一瞬でもあれ?って思った人にこの記事が届いてお調べになるお時間をお助けできれば幸いです。

- ちなみにGRUもLSTMと同様に

bidirectional=TrueでBidirectional GRUになります。出力の形式は上のLSTMの仕様がわかっていれば何の問題もないかと思います。おわり

- 投稿日:2019-11-12T22:38:59+09:00

【株価分析】日経平均でpandas学習(005:年/年月ごとのグルーピング~統計情報の確認)

前回(ローソク足チャート(仮名)まで)の続きから

前回はローソク足チャートを色々変更加えて編集しようと思ったけど、それより先にgroupbyの機能についてまとめておきたかったので、先に本稿を記載します。

前回までのプログラム(再掲)

Study_Code.pyimport pandas as pd import logging # 【株価分析】架空データでpandas学習(003)より追加 from pandas import Series, DataFrame import numpy as np import matplotlib.pyplot as plt import matplotlib.dates as mdates from mpl_finance import candlestick_ohlc # ログフォーマットの指定 # %(asctime)s : LogRecord が生成された時刻を人間が読める書式で表したもの。 # %(funcName)s : ロギングの呼び出しを含む関数の名前 # %(levelname)s : メッセージのための文字のロギングレベル # %(lineno)d : ロギングの呼び出しが発せられたソース行番号 # %(message)s : msg % args として求められた、ログメッセージ fomatter = logging.Formatter('%(asctime)s:%(funcName)s:%(levelname)s:%(lineno)d:\n%(message)s') # ロガーの設定(ログレベルをINFO) logger = logging.getLogger(__name__) logger.setLevel(logging.INFO) # ハンドラーの設定(出力ファイルの変更/ログレベルの設定/ログフォーマットの設定) handler = logging.FileHandler('info_log.log') handler.setLevel(logging.INFO) handler.setFormatter(fomatter) logger.addHandler(handler) # CSVファイル(SampleStock01.csv)の文字コードを指定 dframe = pd.read_csv('NikkeiAverage.csv', encoding='SJIS', \ header=1, sep='\t') # 日付型に変換 dframe['日付'] = pd.to_datetime(dframe['日付']) # 日付の列をインデックスに指定する dframe = dframe.set_index('日付') # 始値~終値を数値に変換 dframe = dframe.apply(lambda x: x.str.replace(',','')).astype(np.float32) # ロガー利用に変更 logger.info(dframe) # インデックスを出力 logger.info(dframe.columns) # 始値と終値だけを出力 logger.info(dframe[['始値','終値']]) # インデックスの確認 logger.info(dframe.index) # 型の確認 logger.info(dframe.dtypes) #プロット用データの作成 ohlc = zip(mdates.date2num(dframe.index), dframe['始値'], dframe['終値'], dframe['高値'], dframe['終値']) logger.info(ohlc) # キャンパスの作成 fig = plt.figure() # X軸のフォーマットを整形する ax = plt.subplot() ax.xaxis.set_major_formatter(mdates.DateFormatter('%Y/%m/%d')) # ローソク足チャートを描画する candlestick_ohlc(ax, ohlc, width=0.7, colorup='g', colordown='r') # 画像を保存する plt.savefig('Candle_Chart.png')年/年月ごとにグルーピングする

前回までのプログラムは2016年から2019年までの4年分のデータを一気に扱っていましたが、せっかくインデックスを日付型にしたので、今回は

1. 2016年のデータ

2. 2017年のデータ

3. 2018年のデータ

4. 2019年のデータ

と年ごとにまた

- 2016年1月のデータ

- 2016年2月のデータ

- 2016年3月のデータ ︙

- 2019年10月のデータ

- 2019年11月のデータ

と年月ごとにグルーピングしてみようと思います。

なお、少々記事がくどいので本稿からはポイントのみを記載し、最後の章に全体のプログラムを記載する形にしたいと思います。

確認インデックスの年/年月情報を抽出

まずは、下記ソースコードにて、インデックスの年情報を確認してみます。

Conf_Code.pylogger.info(dframe.index.year)実行結果

info_log2019-11-12 21:40:26,133:<module>:INFO:42: Int64Index([2016, 2016, 2016, 2016, 2016, 2016, 2016, 2016, 2016, 2016, ... 2019, 2019, 2019, 2019, 2019, 2019, 2019, 2019, 2019, 2019], dtype='int64', name='日付', length=942)続いてインデックスの年月情報を確認してみます。

Conf_Code.pylogger.info([dframe.index.year, dframe.index.month])実行結果

info_log2019-11-12 22:12:26,052:<module>:INFO:42: [Int64Index([2016, 2016, 2016, 2016, 2016, 2016, 2016, 2016, 2016, 2016, ... 2019, 2019, 2019, 2019, 2019, 2019, 2019, 2019, 2019, 2019], dtype='int64', name='日付', length=942), Int64Index([ 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ... 10, 10, 10, 10, 10, 11, 11, 11, 11, 11], dtype='int64', name='日付', length=942)]※年月情報でグルーピングする場合は、[dframe.index.year, dframe.index.month]のようにリストの形で渡して上げる必要があるようです。

(他にいい方法があったら随時訂正します)年ごとにグルーピング

Conf_Code.pyfor Conf_DF in dframe.groupby([dframe.index.year]) : logger.info(Conf_DF)実行結果

info_log2019-11-12 21:49:34,031:<module>:INFO:44: (2016, 始値 高値 安値 終値 日付 2016-01-04 18818.580078 18951.119141 18394.429688 18450.980469 2016-01-05 18398.759766 18547.380859 18327.519531 18374.000000 2016-01-06 18410.570312 18469.380859 18064.300781 18191.320312 2016-01-07 18139.769531 18172.039062 17767.339844 17767.339844 2016-01-08 17562.230469 17975.310547 17509.640625 17697.960938 ... ... ... ... ... 2016-12-26 19394.410156 19432.480469 19385.939453 19396.640625 2016-12-27 19353.429688 19478.580078 19352.060547 19403.060547 2016-12-28 19392.109375 19442.130859 19364.730469 19401.720703 2016-12-29 19301.039062 19301.039062 19092.220703 19145.140625 2016-12-30 18997.679688 19176.810547 18991.589844 19114.369141 [245 rows x 4 columns]) 2019-11-12 21:49:34,051:<module>:INFO:44: (2017, 始値 高値 安値 終値 日付 2017-01-04 19298.679688 19594.160156 19277.929688 19594.160156 2017-01-05 19602.099609 19615.400391 19473.279297 19520.689453 2017-01-06 19393.550781 19472.369141 19354.439453 19454.330078 2017-01-10 19414.830078 19484.900391 19255.349609 19301.439453 2017-01-11 19358.640625 19402.169922 19325.460938 19364.669922 ... ... ... ... ... 2017-12-25 22909.410156 22948.830078 22870.189453 22939.179688 2017-12-26 22922.949219 22950.150391 22877.630859 22892.689453 2017-12-27 22854.390625 22936.160156 22854.390625 22911.210938 2017-12-28 22912.050781 22954.449219 22736.429688 22783.980469 2017-12-29 22831.490234 22881.210938 22753.199219 22764.939453 [247 rows x 4 columns]) 2019-11-12 21:49:34,069:<module>:INFO:44: (2018, 始値 高値 安値 終値 日付 2018-01-04 23073.730469 23506.330078 23065.199219 23506.330078 2018-01-05 23643.000000 23730.470703 23520.519531 23714.529297 2018-01-09 23948.970703 23952.609375 23789.029297 23849.990234 2018-01-10 23832.810547 23864.759766 23755.449219 23788.199219 2018-01-11 23656.390625 23734.970703 23601.839844 23710.429688 ... ... ... ... ... 2018-12-21 20310.500000 20334.730469 20006.669922 20166.189453 2018-12-25 19785.429688 19785.429688 19117.960938 19155.740234 2018-12-26 19302.589844 19530.349609 18948.580078 19327.060547 2018-12-27 19706.189453 20211.570312 19701.759766 20077.619141 2018-12-28 19957.880859 20084.380859 19900.039062 20014.769531 [245 rows x 4 columns]) 2019-11-12 21:49:34,088:<module>:INFO:44: (2019, 始値 高値 安値 終値 日付 2019-01-04 19655.130859 19692.580078 19241.369141 19561.960938 2019-01-07 19944.609375 20266.220703 19920.800781 20038.970703 2019-01-08 20224.669922 20347.919922 20106.359375 20204.039062 2019-01-09 20366.300781 20494.349609 20331.199219 20427.060547 2019-01-10 20270.880859 20345.919922 20101.929688 20163.800781 ... ... ... ... ... 2019-11-01 22730.490234 22852.720703 22705.599609 22850.769531 2019-11-05 23118.789062 23328.519531 23090.939453 23251.990234 2019-11-06 23343.509766 23352.560547 23246.570312 23303.820312 2019-11-07 23283.140625 23336.000000 23253.320312 23330.320312 2019-11-08 23550.039062 23591.089844 23313.410156 23391.869141 [205 rows x 4 columns])dframe.groupby([dframe.index.year])にて、グルーピングすれば

1. 2016年は[245 rows x 4 columns]

2. 2017年は[247 rows x 4 columns]

3. 2018年は[245 rows x 4 columns]

4. 2019年は[205 rows x 4 columns]と正常にデータを抽出出来ました。

グルーピングする前が[942 rows x 4 columns]だったので、変更された点が分かります。

ただ少し気になるのは

読み込み元のデータが

2019/11/8 23,550.04 23,591.09 23,313.41 23,391.87

に対してデータフレームに格納される値は

2019-11-08 23550.039062 23591.089844 23313.410156 23391.869141

だった(他の日も全て)ので、おそらくdframe = dframe.apply(lambda x: x.str.replace(',','')).astype(np.float32)で変換した時に小数点以下第2位以下が正しく変換出来ていないようです。

正直2019年11月12日時点では株価分析において小数点以下の数字を気にする必要性を感じないので無視しますが、科学計算をする場合は丸め誤差問題に苦しみそうな気がします・・・

年月ごとにグルーピング

Conf_Code.pyfor Conf_DF in dframe.groupby([dframe.index.year, dframe.index.month]) : logger.info(Conf_DF)実行結果

info_log(前略) 2019-11-12 22:05:00,120:<module>:INFO:45: ((2019, 11), 始値 高値 安値 終値 日付 2019-11-01 22730.490234 22852.720703 22705.599609 22850.769531 2019-11-05 23118.789062 23328.519531 23090.939453 23251.990234 2019-11-06 23343.509766 23352.560547 23246.570312 23303.820312 2019-11-07 23283.140625 23336.000000 23253.320312 23330.320312 2019-11-08 23550.039062 23591.089844 23313.410156 23391.869141)小数点以下第2位以下にゴミが入っているのは相変わらずですが、、、

月ごとの統計情報を確認

前章にて月ごとに分割出来たので、各月の統計情報を確認してみます。

Conf_Code.pydef Output_Describe(temp_DF) : logger.info(temp_DF.index) logger.info(temp_DF.describe()) dframe.groupby([dframe.index.year, dframe.index.month]).apply(Output_Describe)実行結果

info_log(前略) 2019-11-12 22:25:51,012:Output_Describe:INFO:43: DatetimeIndex(['2019-10-01', '2019-10-02', '2019-10-03', '2019-10-04', '2019-10-07', '2019-10-08', '2019-10-09', '2019-10-10', '2019-10-11', '2019-10-15', '2019-10-16', '2019-10-17', '2019-10-18', '2019-10-21', '2019-10-23', '2019-10-24', '2019-10-25', '2019-10-28', '2019-10-29', '2019-10-30', '2019-10-31'], dtype='datetime64[ns]', name='日付', freq=None) 2019-11-12 22:25:51,043:Output_Describe:INFO:44: 始値 高値 安値 終値 count 21.000000 21.000000 21.000000 21.000000 mean 22173.896484 22250.916016 22117.458984 22197.476562 std 610.297974 598.321411 619.635559 591.679626 min 21316.179688 21410.199219 21276.009766 21341.740234 25% 21494.480469 21629.240234 21483.179688 21587.779297 50% 22451.150391 22522.390625 22424.919922 22451.859375 75% 22725.439453 22780.990234 22704.330078 22750.599609 max 22953.169922 23008.429688 22935.349609 22974.130859 (後略)2019年10月のデータを元に終値カラムで確認すると、

- データ数が21日分

- 2019年10月の日経平均の平均価格(ややこしいな)が、終値で22197.476562円

- 分散が591.679626

- 一番安かった価格(0%点)が21341.740234円

- 2019年10月の価格帯で25%点の価格が21587.779297円

- 2019年10月の価格帯で25%点の価格が22451.859375円

- 2019年10月の価格帯で25%点の価格が22750.599609円

- 一番高かった価格(100%点)が22974.130859円

と確認できます。

執筆中(中途半端な記事が並んでごめんなさい。最後までまとめますが、覚書は覚えている時に書いておかないとすぐ忘れてしまうので、、、)

分散ってどういう意味なのか?

これをグラフで可視化するとどうなるか?

一番安かったのは2019年10月の何日だったのか?等以降の章に記載したいと思います。

- 投稿日:2019-11-12T22:32:21+09:00

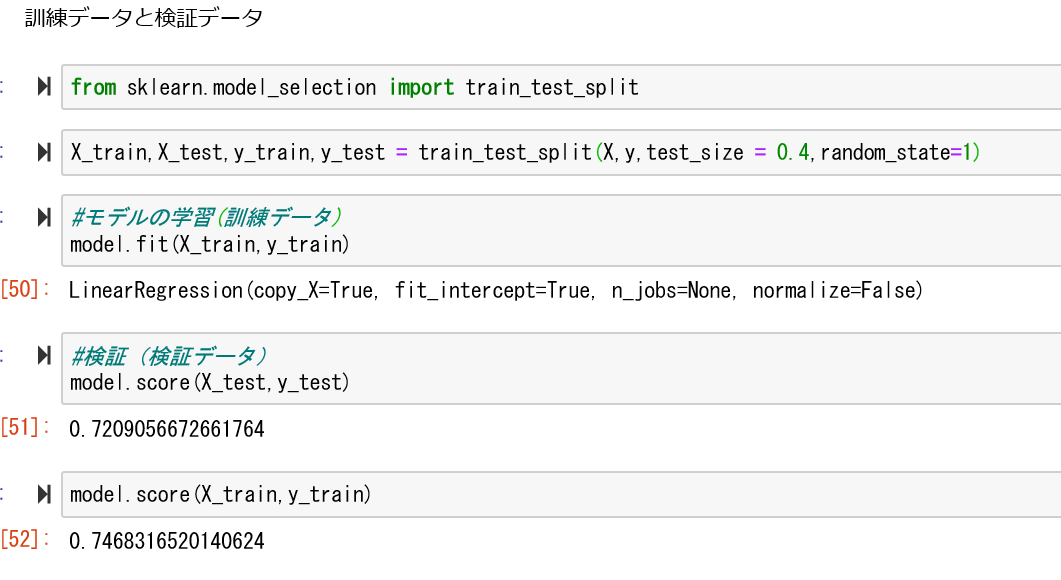

スケーリング

- 投稿日:2019-11-12T22:05:15+09:00

強化学習6 初めてのChainerRL

ChainerRLクイックリファレンス

https://chainer-colab-notebook.readthedocs.io/ja/latest/notebook/hands_on/chainerrl/quickstart.html強化学習5まで終了しているのが前提です。

クイックリファレンスを参照しながら、以下のファイルを作ります。train.pyimport chainer import chainer.functions as F import chainer.links as L import chainerrl import gym import numpy as np env = gym.make('CartPole-v0') print('observation space:', env.observation_space) print('action space:', env.action_space) obs = env.reset() env.render() print('initial observation:', obs) action = env.action_space.sample() obs, r, done, info = env.step(action) print('next observation:', obs) print('reward:', r) print('done:', done) print('info:', info) class QFunction(chainer.Chain): def __init__(self, obs_size, n_actions, n_hidden_channels=50): super().__init__() with self.init_scope(): self.l0 = L.Linear(obs_size, n_hidden_channels) self.l1 = L.Linear(n_hidden_channels, n_hidden_channels) self.l2 = L.Linear(n_hidden_channels, n_actions) def __call__(self, x, test=False): """ Args: x (ndarray or chainer.Variable): An observation test (bool): a flag indicating whether it is in test mode """ h = F.tanh(self.l0(x)) h = F.tanh(self.l1(h)) return chainerrl.action_value.DiscreteActionValue(self.l2(h)) obs_size = env.observation_space.shape[0] n_actions = env.action_space.n q_func = QFunction(obs_size, n_actions) optimizer = chainer.optimizers.Adam(eps=1e-2) optimizer.setup(q_func) # Set the discount factor that discounts future rewards. gamma = 0.95 # Use epsilon-greedy for exploration explorer = chainerrl.explorers.ConstantEpsilonGreedy( epsilon=0.3, random_action_func=env.action_space.sample) # DQN uses Experience Replay. # Specify a replay buffer and its capacity. replay_buffer = chainerrl.replay_buffer.ReplayBuffer(capacity=10 ** 6) # Since observations from CartPole-v0 is numpy.float64 while # Chainer only accepts numpy.float32 by default, specify # a converter as a feature extractor function phi. phi = lambda x: x.astype(np.float32, copy=False) # Now create an agent that will interact with the environment. agent = chainerrl.agents.DoubleDQN( q_func, optimizer, replay_buffer, gamma, explorer, replay_start_size=500, update_interval=1, target_update_interval=100, phi=phi) n_episodes = 200 max_episode_len = 200 for i in range(1, n_episodes + 1): obs = env.reset() reward = 0 done = False R = 0 # return (sum of rewards) t = 0 # time step while not done and t < max_episode_len: # Uncomment to watch the behaviour # env.render() action = agent.act_and_train(obs, reward) obs, reward, done, _ = env.step(action) R += reward t += 1 if i % 10 == 0: print('episode:', i, 'R:', R, 'statistics:', agent.get_statistics()) agent.stop_episode_and_train(obs, reward, done) print('Finished.') agent.save('agent') env.close()※env.close()を入れないとエラー表示が出ます。

ちゃんと動けば、以下のように出力されます。

observation space: Box(4,) action space: Discrete(2) initial observation: [-0.04736688 -0.01970095 -0.00356997 0.01937746] next observation: [-0.0477609 0.17547202 -0.00318242 -0.27442969] reward: 1.0 done: False info: {} episode: 10 R: 54.0 statistics: [('average_q', 0.02431227437087797), ('average_loss', 0), ('n_updates', 0)] episode: 20 R: 38.0 statistics: [('average_q', 0.6243046798922441), ('average_loss', 0.08867046155807262), ('n_updates', 378)] episode: 30 R: 46.0 statistics: [('average_q', 2.2610338271644586), ('average_loss', 0.09550022600040467), ('n_updates', 784)] episode: 40 R: 84.0 statistics: [('average_q', 5.323362298387771), ('average_loss', 0.16771472656243475), ('n_updates', 1399)] episode: 50 R: 91.0 statistics: [('average_q', 9.851513830734694), ('average_loss', 0.19145745620246343), ('n_updates', 2351)] episode: 60 R: 99.0 statistics: [('average_q', 14.207080180752635), ('average_loss', 0.22097823899753388), ('n_updates', 3584)] episode: 70 R: 200.0 statistics: [('average_q', 17.49337381852232), ('average_loss', 0.18525375351216344), ('n_updates', 5285)] episode: 80 R: 124.0 statistics: [('average_q', 18.933387631649587), ('average_loss', 0.1511605453710412), ('n_updates', 7063)] episode: 90 R: 200.0 statistics: [('average_q', 19.55727598346719), ('average_loss', 0.167370220872378), ('n_updates', 8496)] episode: 100 R: 200.0 statistics: [('average_q', 19.92113421424675), ('average_loss', 0.15092426599174535), ('n_updates', 10351)] episode: 110 R: 161.0 statistics: [('average_q', 19.870179660112395), ('average_loss', 0.1369066775700466), ('n_updates', 12169)] episode: 120 R: 200.0 statistics: [('average_q', 19.985680296882315), ('average_loss', 0.13667809001004586), ('n_updates', 13991)] episode: 130 R: 200.0 statistics: [('average_q', 20.016279858512945), ('average_loss', 0.14053696154447365), ('n_updates', 15938)] episode: 140 R: 180.0 statistics: [('average_q', 19.870299413261478), ('average_loss', 0.1270716956269478), ('n_updates', 17593)] episode: 150 R: 200.0 statistics: [('average_q', 19.990808581945565), ('average_loss', 0.1228807602095278), ('n_updates', 19442)] episode: 160 R: 130.0 statistics: [('average_q', 19.954955203815164), ('average_loss', 0.14701205384726732), ('n_updates', 21169)] episode: 170 R: 133.0 statistics: [('average_q', 19.994069560095422), ('average_loss', 0.12502104946859763), ('n_updates', 22709)] episode: 180 R: 200.0 statistics: [('average_q', 19.973195015705674), ('average_loss', 0.1227321977377075), ('n_updates', 24522)] episode: 190 R: 200.0 statistics: [('average_q', 20.050942533128573), ('average_loss', 0.09264820379188309), ('n_updates', 26335)] episode: 200 R: 191.0 statistics: [('average_q', 19.81062306392066), ('average_loss', 0.11778217212419012), ('n_updates', 28248)] Finished.

- 投稿日:2019-11-12T21:44:27+09:00

asyncio を使って非同期処理をしてみた

きっかけ

asyncioの良さげなサンプルコードがなかったのですが、Python でのオンデマンド・データ, 第 3 回 コルーチンと asyncioがレストランにいるウェイターが複数のオーダーに対応するといったより具体的なストーリーを交えて説明していたので一番分かりやすくて参考になります。

よく見かけるpython3 の async/awaitを理解するやPythonにおける非同期処理: asyncio逆引きリファレンスよりも良いです。開発

import asyncio import time async def start_time(src): await asyncio.sleep(src) print("START!!!") async def main_process(span): idx = 1 while True: await asyncio.sleep(span) num_active_tasks = len([ task for task in asyncio.Task.all_tasks(loop) if not task.done()]) if num_active_tasks == 1: break print("[run:{}]{}秒経過".format(num_active_tasks, idx * span)) idx += 1 async def end_time(src): await asyncio.sleep(src) print("END!!!") if __name__ == "__main__": loop = asyncio.get_event_loop() try: loop.run_until_complete( asyncio.gather( start_time(10), main_process(1), end_time(20) ) ) finally: loop.close()注目点は

len([ task for task in asyncio.Task.all_tasks(loop) if not task.done()])

でasyncio.Task.all_tasks(loop) if not task.done()とすることで現在常駐しているタスクを取得することができます。結果

出力結果は下記の通りです。

メイン処理のみ起動している場合はloopから抜けています。[run:3]1秒経過 [run:3]2秒経過 [run:3]3秒経過 [run:3]4秒経過 [run:3]5秒経過 [run:3]6秒経過 [run:3]7秒経過 [run:3]8秒経過 [run:3]9秒経過 START!!! [run:2]10秒経過 [run:2]11秒経過 [run:2]12秒経過 [run:2]13秒経過 [run:2]14秒経過 [run:2]15秒経過 [run:2]16秒経過 [run:2]17秒経過 [run:2]18秒経過 [run:2]19秒経過 END!!!おわりに

asyncio.Task.all_tasks()ですが Python3.7 以降では非推奨で3.9では削除されるとのことです。特にasyncioの部分でversionが上がるごとに書き方がかなり様変わりしそうです。

(Python3.8 doc Task オブジェクト を参照)参考したリンク

- 投稿日:2019-11-12T21:35:09+09:00

Scikit-learn のさわり

- 投稿日:2019-11-12T21:24:17+09:00

初心者がUE4でルービックキューブ風なものを作って強化学習用のライブラリにしたい #4

前回に引き続き初心者がUE4を絡めたPythonライブラリを作れないか色々進めていく記事です(ほぼ自分のための備忘録としての面が強い・・)。

Pythonスクリプトでのimportなどはできるのか試してみる

PyActorのブループリントにていずれかのPythonモジュールを指定するわけですが、その際に他のScriptフォルダー以下のPythonモジュールをimportできるのか試してみました。

ue.logなどでコンソール出力してみた感じ、どうやらPyActorのブループリントで指定したもののみ実行されるようです。

他のモジュールのimport自体はエラーが発生しないようなのですが、そのモジュールで追加してある関数などを呼び出すとエラーになってしまいます。

pipでインストールしてあるものは問題なく使えるものの、基本的に1つのPyActorに対して1つのモジュールと考えておいたほうが良さそうですね。ただ、それだと共通の処理などで困ってしまいます。そこで、pipでライブラリが追加されるフォルダにcommonといったフォルダを追加してimportできないか試してみます。

Plugins\UnrealEnginePython\Binaries\Win64のpipでライブラリフォルダが追加されるプラグインディレクトリにcommonというフォルダを追加し、SQLite関係のものの共通処理を書く想定でsqlite_utils.pyというファイルを追加しました。そのファイルに以下のような記述を試しにしておきます。sqlite_utils.pydef print_test(ue): ue.log('sqlite_utils test')続いてPyActorで指定したモジュールで以下ように記述を追加します。

import unreal_engine as ue from common import sqlite_utils sqlite_utils.print_test(ue=ue)pipで扱われるディレクトリはパスが通っているはずなので、きっとimportできるはず・・・という想定で試しています。

UE4でプレビュー(というよりPlayの方が単語が正しいか・・・)してみます。無事importしたモジュールが呼び出されているようです。

複数のモジュールをまたぐPythonの記述が必要な時にはライブラリフォルダにモジュール追加する形で良さそうですね。また、common.sqlite_utilsモジュールでunreal_engineを直接importせずに、PyActorで指定したモジュールから、関数の引数で渡していますが、これはPyActorで指定したモジュールじゃないとue.logとしても動作してくれませんでした。おそらくPyActorで指定したモジュール以外で、unreal_engineモジュールのimportは使えないのでしょう。

そのため、共通モジュール側でunreal_engineモジュールが必要な場合は今回みたく引数で渡すようにして対応します。Pythonスクリプトのテストをどうしようか考える

開発上、Pythonスクリプトでテストを書きたいところです。

しかし、前述の通りPyActorのクラス1つにつき1モジュールという制約があり、且つunreal_engineモジュールが絡むものなどはUE4でPlayしないとテストができないので、pytestなんかのテストランナーが使えません。そこで、イレギュラーな感じですが以下のように進めてみます。

- 各PyActorで指定したモジュール自体にtest_というプリフィクスでテストの関数を書いていく。

- 共通モジュールに簡単な自前のテストランナー(凝ったものは作らない)用のコードを用意する。

- PyActor指定モジュールのトップレベルの箇所に、自前のテストランナーに自身のモジュールを引数で渡すようにし、渡されたテストランナー側でtest_というプリフィクスの関数を一通り実行するようにする。

とりあえず自前のテストランナーから対応していきます。

common.python_test_runner.py"""各Pythonスクリプトのテストの実行を扱うモジュール。 Notes ----- - unreal_engine モジュールを絡ませる都合、テスト用のモジュールを分けずに 運用を行う。 """ from datetime import datetime import inspect def run_tests(ue, target_module): """ 対象のモジュールに対して定義されているテストを実行する。 Parameters ---------- ue : unreal_engine 各PyActorで指定されたPythonモジュール内でimportされた、 UnrealEnginePythonライブラリのモジュール。 target_module : module テスト対象のモジュール。モジュール内でtest_というプリフィクスの 関数が実行される。 """ ue.log( '%s %sモジュールのテストを開始...' % (datetime.now(), target_module.__name__)) members = inspect.getmembers(target_module) for obj_name, obj_val in members: if not inspect.isfunction(obj_val): continue if not obj_name.startswith('test_'): continue ue.log( '%s 対象の関数 : %s' % (datetime.now(), obj_name)) pre_dt = datetime.now() obj_val() timedelta = datetime.now() - pre_dt ue.log('%s ok. %s秒' % (datetime.now(), timedelta.total_seconds()))細かいところは後で調整するとして、一旦はシンプルな実装でいいでしょう。

ビルトインのinspectモジュールのgetmembers関数で、引数に指定したモジュールのメンバー要素を取れるのでそれをループで回し、isfunction関数で関数かチェック、且つ関数名がtest_というプリフィクスを持つ場合にのみ処理を流すようにしています。

後はテスト時間や対象のモジュール名・関数名などをコンソール出力する記述のみです。別途、PyActorで指定するモジュールで、UE4→Pythonライブラリという流れでデータを渡すためのSQLite書き込み用のモジュールを用意します。

そちらに、後で消しますがテストランナーの動作確認用としてaddという加算の関数を用意しました。to_python_sqlite_writer.py"""UE4からPythonライブラリ用のSQLiteへのデータの書き込みを扱う ためのモジュール。 """ import sys import importlib import time import unittest import unreal_engine as ue from common import python_test_runner importlib.reload(python_test_runner) def add(a, b): time.sleep(1) return a + b def test_add(): added_val = add(a=1, b=3) assert added_val == 4 python_test_runner.run_tests( ue=ue, target_module=sys.modules[__name__])テスト時間の表示確認のため、わざと関数内で1秒スリープさせています。

前述の通り、テストも同一のモジュール内に書くようにしています。

最後にトップレベルの箇所にテストランナーの処理を呼び出しています。自身のモジュールはsys.moduels[__name__]とすることで取れます。なお、PyActorで指定したモジュールはコード更新後UE4側で自動でリロードされるようにしました(設定のポップアップが出たため)が、共通モジュールのものなどは自動でリロードされないようです。そのため、コード変更が即時で反映されなかったりするため、即時反映のためにimportlibでreloadさせています(最終的には消すかも・・)。

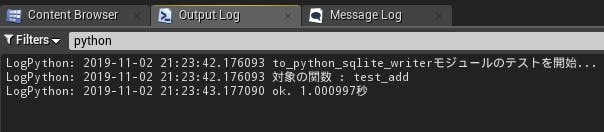

UE4でPlayしてみます。

テストが流れました。細かい点は必要に応じて後で調整するとして、とりあえずは大丈夫そうですね・・・

テストライブラリでnoseを入れておく

最近プライベートでコードを書くときはテストランナーとかの優秀さでpytestを使うことが多いのですが、今回はassertの関数だけ使えればいい(assert_equalとかassert_raisesとか)ので、楽をするためnoseのテストライブラリを入れておきます。

$ ./python.exe -m pip install --target . noseSuccessfully installed nose-1.3.7UE4上で使えることを確認するため、少し前にテストの検証で書いたコードを調整します。

to_python_sqlite_writer.pyfrom nose.tools import assert_equal ... def test_add(): added_val = add(a=1, b=3) assert_equal(added_val, 4)問題なく動いているようです。

SQLiteでの読み書きの部分を進めてみる

前回SQLite用にSQLAlchemyを入れて最低限importなどができるところまで対応しましたが、もう少し検証で問題ないことを確認するのと、暫定ファイルの整理などをしていきます。

まずはh5pyなどの検証で使っていたpython_and_h5py_test.pyとそれに紐づくブループリントクラスを削除しておきます。まずは共通モジュールでの、SQLiteのSQLAlchemyのパスを指定するための文字列を取得する処理を追加します。

common\sqlite_utils.py"""SQLite関係の共通処理を記述したモジュール。 """ import os import sys DESKTOP_FOLDER_NAME = 'cubicePuzzle3x3' def get_sqlite_engine_file_path(file_name): """ SQLiteのSQLAlchemy用のエンジン指定用のファイルパスを取得する。 Parameters ---------- file_name : str 拡張しを含んだ対象のSQLファイル名。 Returns ------- sqlite_file_path : str SQLite用のエンジン指定用のパスの文字列。 sqlite:/// から始まり、デスクトップにSQLite用のフォルダが作られる 形で設定される。 Notes ----- 保存先のフォルダが存在しない場合には生成される。 """ dir_path = os.path.join( os.environ['HOMEPATH'], 'Desktop', DESKTOP_FOLDER_NAME) os.makedirs(dir_path, exist_ok=True) sqlite_file_path = 'sqlite:///{dir_path}/{file_name}'.format( dir_path=dir_path, file_name=file_name, ) return sqlite_file_path書いていて気づきましたが、これだと共通モジュールに対するテストが書けません(このモジュール自体でueモジュールをimportてきない)。

そのため、共通モジュールのテストを実行するためのモジュールとPyActorのブループリントクラスを追加しておいて、そちら経由で各共通モジュールのテストを実行する形で対応します。

Content\Scripts\run_common_module_tests.py"""Pythonプラグインのcommonディレクトリ以下のモジュールに対して テストを実行する。 """ import sys import inspect import unreal_engine as ue from common import python_test_runner from common.tests import test_sqlite_utils NOT_TEST_TARGET_MODULES = [ sys, inspect, ue, python_test_runner, ] members = inspect.getmembers(sys.modules[__name__]) for obj_name, obj_val in members: if not inspect.ismodule(obj_val): continue is_in = obj_val in NOT_TEST_TARGET_MODULES if is_in: continue python_test_runner.run_tests(ue=ue, target_module=obj_val)BP側はBP_RunCommonModuleTestsという名前にしました。

テストを書いていきます。共通モジュールの方は、ueモジュールのimportとかは前述のコードによって不要なのと、モジュールが分かれていても問題が無いため、普通のテストと同じようにテストモジュール用のディレクトリを挟んでtest_<モジュール名>.pyという形で進めていきます。

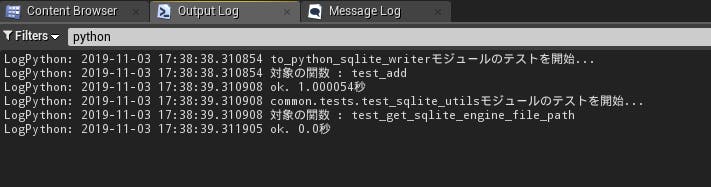

common\tests\test_sqlite_utils.py"""sqlite_utils モジュールのテスト用のモジュール。 """ from nose.tools import assert_equal, assert_true from common import sqlite_utils def test_get_sqlite_engine_file_path(): sqlite_file_path = sqlite_utils.get_sqlite_engine_file_path( file_name='test_dbfile.sqlite') assert_true( sqlite_file_path.startswith('sqlite:///') ) is_in = sqlite_utils.DESKTOP_FOLDER_NAME in sqlite_file_path assert_true(is_in) assert_true( sqlite_file_path.endswith('/test_dbfile.sqlite') )UE4をPlayしてみます。

大丈夫そうですね。これで共通モジュール側もテストが書けるようになりました。

問題点として、pytestなどで用意されている、特定のモジュールや特定の関数のみのテストが現状できない・・・といったところでしょうか。

この点は、テストが増えてきて結構しんどい感じになってきたら考えます(特定のモジュールだけさくっとテストできるようにしたりなど)。

実装が終わるまで、テスト時間が気にならないレベルのままな可能性も高いですしね・・・SQLiteのテスト用の挙動の確認と、初期化の処理とPyActorのスクリプトでクラスを挟んだ場合のテストを考える

UE4で作業していて、SQLiteを使ったテストをした際に、Playをもう一度実行してもSQLiteのファイルに対してロックがかかったままというケースが発生しました(途中でエラーになった場合など)。

実際にパッケージングされたときなどは一度アプリを落としてとなったりしそうな気もしますが、開発中はロックを解除するために毎回UE4を再起動したり・・・というのは手間なため、Playのたびに別のSQLiteのファイルになるようにPlayを押したタイミングでの日時情報をファイル名に差し込むようにしておきます。

initializer.pyという名前とPyActorのブループリントを追加します。Content\Scripts\initializer.py"""ゲーム開始時などに最初に実行される処理を記述したモジュール。 """ import json from datetime import datetime import os import sys import time import importlib from nose.tools import assert_equal, assert_true import unreal_engine as ue from common import const, file_helper from common.python_test_runner import run_tests importlib.reload(const) importlib.reload(file_helper) def save_session_data_json(): """ 1回のゲームセッションにおけるスタート時の情報を保持するための JSONファイルの保存を行う。 """ session_data_dict = { const.SESSION_DATA_KEY_START_DATETIME: str(datetime.now()), } file_path = file_helper.get_session_json_file_path() with open(file_path, mode='w') as f: json.dump(session_data_dict, f) ue.log('initialized.') save_session_data_json() def test_save_session_data_json(): pre_session_json_file_name = const.SESSION_JSON_FILE_NAME const.SESSION_JSON_FILE_NAME = 'test_game_session.json' expected_file_path = file_helper.get_session_json_file_path() save_session_data_json() assert_true(os.path.exists(expected_file_path)) with open(expected_file_path, 'r') as f: json_str = f.read() data_dict = json.loads(json_str) expected_key_list = [ const.SESSION_DATA_KEY_START_DATETIME, ] for key in expected_key_list: has_key = key in data_dict assert_true(has_key) os.remove(expected_file_path) const.SESSION_JSON_FILE_NAME = pre_session_json_file_name run_tests( ue=ue, target_module=sys.modules[__name__])ファイル操作用の共通モジュールとそのテストも追加します。

Win64\common\file_helper.py"""ファイル操作関係の共通処理を記述したモジュール。 """ import os import time import json from datetime import datetime from common.const import DESKTOP_FOLDER_NAME from common import const def get_desktop_data_dir_path(): """ デスクトップのデータ保存用のディレクトリを取得する。 Returns ------- dir_path : str 取得されたデスクトップのデータ保存用のディレクトリパス。 Notes ----- 保存先のフォルダが存在しない場合には生成される。 """ dir_path = os.path.join( os.environ['HOMEPATH'], 'Desktop', DESKTOP_FOLDER_NAME) os.makedirs(dir_path, exist_ok=True) return dir_path def get_session_json_file_path(): """ 1回のゲームセッションにおけるスタート時の情報を保持するための JSONファイルのパスを取得する。 Returns ------- file_path : str 対象のファイルパス。 """ file_path = os.path.join( get_desktop_data_dir_path(), const.SESSION_JSON_FILE_NAME ) return file_path def get_session_start_time_str(remove_symbols=True): """ 1回のゲームセッション開始時の日時の文字列をJSONファイルから取得する。 SQLiteのファイル名などに利用される。 Parameters ---------- remove_symbols : bool, default True 返却値の文字列から記号を取り除き、半角整数のみの値に 変換するかどうか。 Returns ------- session_start_time_str : str 1回のゲームセッション開始時の日時の文字列。 """ time.sleep(0.1) file_path = get_session_json_file_path() with open(file_path, mode='r') as f: data_dict = json.load(f) session_start_time_str = str( data_dict[const.SESSION_DATA_KEY_START_DATETIME]) if remove_symbols: session_start_time_str = session_start_time_str.replace('-', '') session_start_time_str = session_start_time_str.replace('.', '') session_start_time_str = session_start_time_str.replace(':', '') session_start_time_str = session_start_time_str.replace(' ', '') return session_start_time_strSQLite共通処理用のモジュールも追加しておきます。

Win64\common\sqlite_utils.py"""SQLite関係の共通処理を記述したモジュール。 """ import os import sys import sqlalchemy from sqlalchemy.orm import sessionmaker from common import file_helper def get_sqlite_engine_file_path(file_name): """ SQLiteのSQLAlchemy用のエンジン指定用のファイルパスを取得する。 Parameters ---------- file_name : str 拡張しを含んだ対象のSQLファイル名。 Returns ------- sqlite_file_path : str SQLite用のエンジン指定用のパスの文字列。 sqlite:/// から始まり、デスクトップにSQLite用のフォルダが作られる 形で設定される。 Notes ----- 保存先のフォルダが存在しない場合には生成される。 """ dir_path = file_helper.get_desktop_data_dir_path() sqlite_file_path = 'sqlite:///{dir_path}/{file_name}'.format( dir_path=dir_path, file_name=file_name, ) return sqlite_file_path def create_session(sqlite_file_name, declarative_meta): """ SQLiteのセッションを生成する。 Parameters ---------- sqlite_file_name : str 対象のSQLiteファイルの名称。 declarative_meta : DeclarativeMeta 対象のSQLiteの各テーブルのメタデータを格納したオブジェクト。 Returns ------- session : Session 生成されたSQLiteのセッション。 """ sqlite_file_path = get_sqlite_engine_file_path( file_name=sqlite_file_name) engine = sqlalchemy.create_engine(sqlite_file_path, echo=True) declarative_meta.metadata.create_all(bind=engine) Session = sessionmaker(bind=engine) session = Session() return sessionWin64\common\tests\test_sqlite_utils.py"""sqlite_utils モジュールのテスト用のモジュール。 """ import os from nose.tools import assert_equal, assert_true from sqlalchemy.ext.declarative import declarative_base from sqlalchemy import Column, Integer from common import sqlite_utils, file_helper def test_get_sqlite_engine_file_path(): sqlite_file_path = sqlite_utils.get_sqlite_engine_file_path( file_name='test_dbfile.sqlite') assert_true( sqlite_file_path.startswith('sqlite:///') ) is_in = file_helper.DESKTOP_FOLDER_NAME in sqlite_file_path assert_true(is_in) assert_true( sqlite_file_path.endswith('/test_dbfile.sqlite') ) def test_create_session(): if not os.path.exists(file_helper.get_session_json_file_path()): return session_start_time_str = file_helper.get_session_start_time_str() sqlite_file_name = 'test_%s.sqlite' % session_start_time_str expected_file_path = sqlite_utils.get_sqlite_engine_file_path( file_name=sqlite_file_name) if os.path.exists(expected_file_path): os.remove(expected_file_path) declarative_meta = declarative_base() class TestTable(declarative_meta): id = Column(Integer, primary_key=True) __tablename__ = 'test_table' session = sqlite_utils.create_session( sqlite_file_name=sqlite_file_name, declarative_meta=declarative_meta) test_data = TestTable() session.add(instance=test_data) session.commit() query_result = session.query(TestTable) for test_data in query_result: assert_true(isinstance(test_data.id, int)) expected_file_path = expected_file_path.replace('sqlite:///', '') assert_true( os.path.exists(expected_file_path)) session.close() os.remove(expected_file_path)initializer.pyを挟んだはいいものの、実際に使うときにはinitializerよりも後にSQLiteに繋ぐモジュールの処理は実行してもらう必要があります。一方で、PyActorでどのモジュールが先に実行されるかは不明です(場合によってはinitializerよりも先に他のモジュールのトップレベルのスクリプトが実行される)。

そこで、initializerの後じゃないと困るものに関してはPyActorでクラスを指定する形で、begin_playメソッド経由でスタートさせるようにします(begin_play経由だと、各モジュールのトップレベルの処理よりも確実に後に実行されるようです。少なくとも現状試した限りでは)。

※以下で1つ暫定のテーブルのモデルを追加してありますが、動作確認後とかに削除します。テストもとりあえずは最低限エラーにならないといった程度のライトなものです。

Content\Scripts\to_python_sqlite_writer.py"""UE4からPythonライブラリ用のSQLiteへのデータの書き込みを扱う ためのモジュール。 """ import sys import importlib import time import unittest import time import unreal_engine as ue from nose.tools import assert_equal, assert_true import sqlalchemy from sqlalchemy.ext.declarative import declarative_base from sqlalchemy import Column, Integer, String from common import python_test_runner, sqlite_utils, file_helper importlib.reload(python_test_runner) importlib.reload(sqlite_utils) declarative_meta = declarative_base() class ToPythonSqliteWriter: class TestTable(declarative_meta): id = Column(Integer, primary_key=True) name = Column(String(length=256)) __tablename__ = 'test_table' def begin_play(self): """ ゲームPlay開始時に実行される関数。 Notes ----- 各モジュールのトップレベルの処理よりは後に実行される。 """ self.session_start_time_str = \ file_helper.get_session_start_time_str() self.SQLITE_FILE_NAME = 'to_python_from_ue4_%s.sqlite'\ % self.session_start_time_str self.session = sqlite_utils.create_session( sqlite_file_name=self.SQLITE_FILE_NAME, declarative_meta=declarative_meta, ) python_test_runner.run_begin_play_test( begin_play_test_func=self.test_begin_play ) def test_begin_play(self): assert_equal( self.session_start_time_str, file_helper.get_session_start_time_str(), ) is_in = 'to_python_from_ue4_' in self.SQLITE_FILE_NAME assert_true(is_in) is_in = '.sqlite' in self.SQLITE_FILE_NAME assert_true(is_in) query_result = self.session.query(self.TestTable) python_test_runner.run_tests( ue=ue, target_module=sys.modules[__name__])また、現在追加したテストランナーが、トップレベルのものしか対応していないので、別途begin_playの特殊なUE4のイベントに絡んだメソッドに対するテストを実行するための

run_begin_play_testという関数を挟んでおきます。Win64\common\python_test_runner.pydef run_begin_play_test(begin_play_test_func): """ PyActorで指定したクラスのbegin_playメソッドに対するテストを 実行する。 Parameters ---------- begin_play_test_func : function 対象のbegin_playメソッドのテスト。 """ begin_play_test_func()現状ほぼ内容は無いですが、後で開発中のみ実行するように処理を挟みます(まだそこまでUE4側と連携できていないので)。

生成されたSQLiteファイルを確認してみる

テストが通ることを確認し、デスクトップを確認してみるととりあえずはファイルが生成されていることが分かります。

内容も少し確認しておきます。

DB Browser for SQLiteをインストールして、内容を確認してみます。とりあえずUE4経由でのSQLiteは問題なく動いてくれているようです。

パッケージングされた環境かどうかの値をPython側で取れるようにする

Python側でも、Is Packaged for Distributionのノードの値を取れるようにし、テストなどが開発中のみ実行されるようにしておきます。

ただ、関数呼び出しがuobject経由でしかできない都合、クラスを経由する必要があり、どうしてもinitializerのトップレベルの部分で処理ができません。

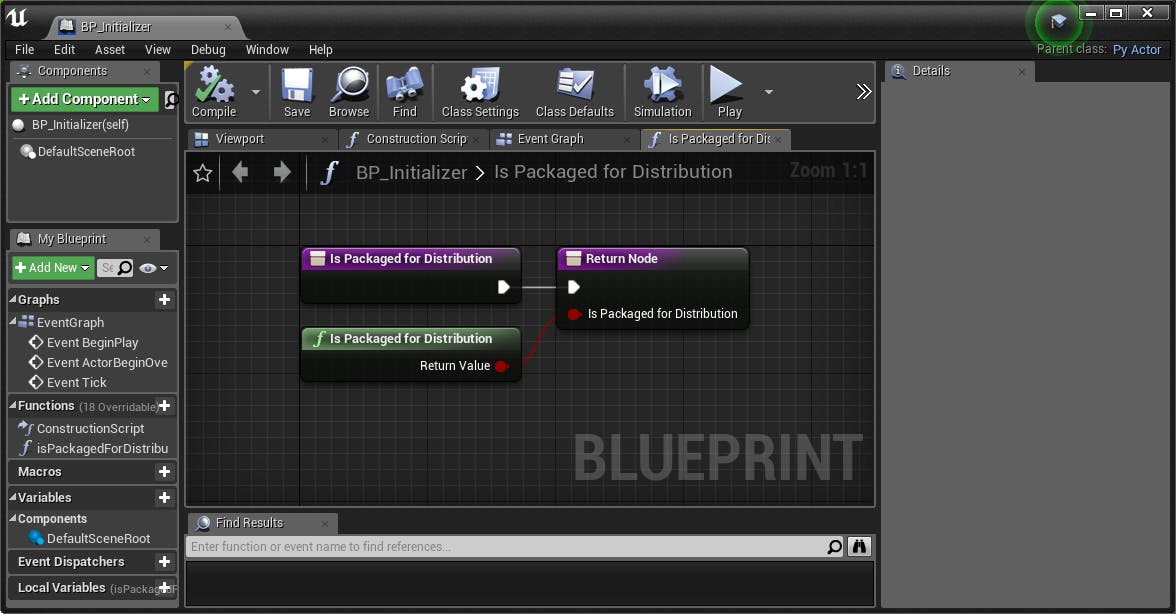

まあ無駄な処理を減らす程度のものなのと、どうこうてきるものでもないので、細かいことは気にせずに進めましょうか・・・PythonからUE4のブループリント上の関数を呼びだす必要があるので、まずはブループリントに対象の関数を追加します。

シンプルに用意されている関数の値を返却するだけの関数です。

この関数無く、直接用意されている関数(紫ではなく緑のもの)をPythonから呼び出せるのかな?と試しましたが、そんなことはなく弾かれたので普通に用意します。また、ブループリント上でクラスの指定をしておきます。

Python側の対応を進めます。

クラスのuobjectを経由する必要があるので、クラスを用意します。Content\Scripts\initializer.pyclass Initializer: def begin_play(self): """ ゲームPlay開始時に実行される関数。 """ self.is_packaged_for_distribution = \ self.uobject.isPackagedForDistribution()[0] _update_packaged_for_distribution_value( is_packaged_for_distribution=self.is_packaged_for_distribution) def _update_packaged_for_distribution_value(is_packaged_for_distribution): """ 配布用にパッケージングされた環境(本番用)かどうかの 真偽値の値を更新する。 Parameters ---------- is_packaged_for_distribution : bool 設定する真偽値。 """ file_path = file_helper.get_session_json_file_path() if os.path.exists(file_path): with open(file_path, mode='r') as f: session_data_dict = json.load(f) else: session_data_dict = {} if is_packaged_for_distribution: is_packaged_for_distribution_int = 1 else: is_packaged_for_distribution_int = 0 with open(file_path, mode='w') as f: session_data_dict[ const.SESSION_DATA_KEY_IS_PACKAGED_FOR_DISTRIBUTION] = \ is_packaged_for_distribution_int json.dump(session_data_dict, f) def test__update_packaged_for_distribution_value(): pre_session_json_file_name = const.SESSION_JSON_FILE_NAME const.SESSION_JSON_FILE_NAME = 'test_game_session.json' expected_file_path = file_helper.get_session_json_file_path() _update_packaged_for_distribution_value( is_packaged_for_distribution=True) with open(expected_file_path, mode='r') as f: session_data_dict = json.load(f) assert_equal( session_data_dict[ const.SESSION_DATA_KEY_IS_PACKAGED_FOR_DISTRIBUTION], 1 ) _update_packaged_for_distribution_value( is_packaged_for_distribution=False) with open(expected_file_path, mode='r') as f: session_data_dict = json.load(f) assert_equal( session_data_dict[ const.SESSION_DATA_KEY_IS_PACKAGED_FOR_DISTRIBUTION], 0 ) os.remove(expected_file_path) const.SESSION_JSON_FILE_NAME = pre_session_json_file_nameなお、

self.uobject.isPackagedForDistribution()[0]という値の取り方をしていますが、ブループリントの関数の返却値が1件だけでもPython側ではタプルで渡されるためにこのようにしています。

UE4上でコンソール出力してもFalseとなっているのに、なんだか分岐がうまくいかない・・と悩むこと数分。

どうやら(False,)みたいなタプル表示ではなくダイレクトにFalseやTrueといった感じでコンソール出力されるようです。これは紛らわしい・・・(せめてコンマを・・・)

型を表示したらtupleになっていて気づきました。値の取得処理に関しても追加しておきます。

Win64\common\file_helper.pydef get_packaged_for_distribution_bool(): """ 配布用にパッケージングされた状態かどうかの真偽値を取得する。 Notes ----- 初回起動時の最初のみ、値の保存前で正常に値が取れないタイミングが 存在する。その場合はFalseが返却される。 Returns ------- is_packaged_for_distribution : bool Trueで配布用にパッケージングされた状態(本番用)、Falseで 開発用。 """ file_path = get_session_json_file_path() if not os.path.exists(file_path): return False with open(file_path, mode='r') as f: json_str = f.read() if json_str == '': session_data_dict = {} else: session_data_dict = json.loads(json_str) has_key = const.SESSION_DATA_KEY_IS_PACKAGED_FOR_DISTRIBUTION \ in session_data_dict if not has_key: return False is_packaged_for_distribution = session_data_dict[ const.SESSION_DATA_KEY_IS_PACKAGED_FOR_DISTRIBUTION] if is_packaged_for_distribution == 1: return True return FalseWin64\common\tests\test_file_helper.pydef test_get_packaged_for_distribution_bool(): pre_session_json_file_name = file_helper.const.SESSION_JSON_FILE_NAME file_helper.const.SESSION_JSON_FILE_NAME = 'test_game_session.json' file_path = file_helper.get_session_json_file_path() if os.path.exists(file_path): os.remove(file_path) # ファイルが存在しない場合の返却値を確認する。 is_packaged_for_distribution = \ file_helper.get_packaged_for_distribution_bool() assert_false(is_packaged_for_distribution) # ファイルは存在するものの、空文字が設定されている場合の # 返却値を確認する。 with open(file_path, 'w') as f: f.write('') is_packaged_for_distribution = \ file_helper.get_packaged_for_distribution_bool() assert_false(is_packaged_for_distribution) # 値に1が設定されている場合の返却値を確認する。 with open(file_path, 'w') as f: session_data_dict = { const.SESSION_DATA_KEY_IS_PACKAGED_FOR_DISTRIBUTION: 1, } json.dump(session_data_dict, f) is_packaged_for_distribution = \ file_helper.get_packaged_for_distribution_bool() assert_true( is_packaged_for_distribution ) # 値に0が設定されている場合の返却値を確認する。 with open(file_path, 'w') as f: session_data_dict = { const.SESSION_DATA_KEY_IS_PACKAGED_FOR_DISTRIBUTION: 0, } json.dump(session_data_dict, f) is_packaged_for_distribution = \ file_helper.get_packaged_for_distribution_bool() assert_false(is_packaged_for_distribution) os.remove(file_path) file_helper.const.SESSION_JSON_FILE_NAME = pre_session_json_file_name以下のようにテストランナーの各所に分岐を挟んでおきます。

Win64\common\python_test_runner.pydef run_tests(ue, target_module): ... is_packaged_for_distribution = \ file_helper.get_packaged_for_distribution_bool() if is_packaged_for_distribution: return ...初期表示のランダムな状態の反映を行う

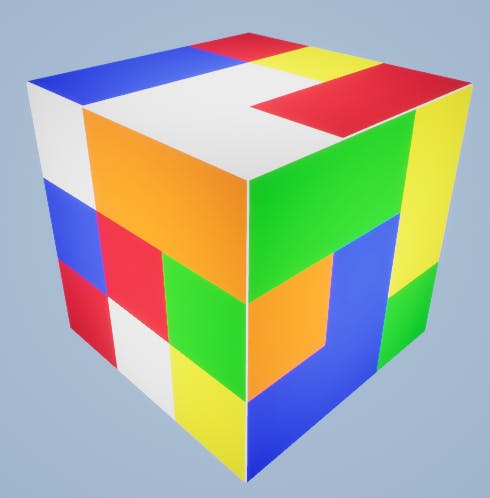

現状、色が揃った状態でスタートするので、これを普通のルービックキューブ的な感じにランダムに回転させておきます。

アニメーションしない即時の回転処理を用意してあるので、そちらを使ってブループリントに関数を追加していきます。

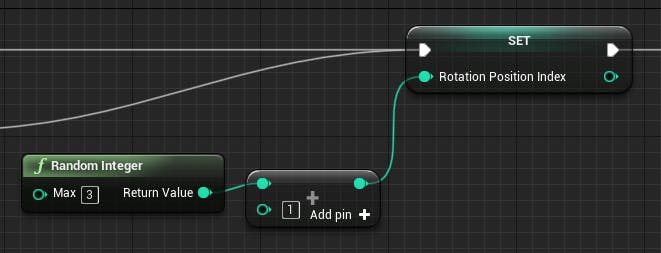

また、環境のリセット処理がOpenAIのGymライブラリでは関数名がresetとなっているので、そちらにならってresetとしておきます(最初だけでなく再度動かす際にも利用します)。まずは何度回すのかの値を取得します。

NumPyのrandintみたいなものがRandom Integerノードで用意されているようなのでそちらを使います。最小値は0、最大値はMax - 1で設定されるようです。

また、そのままだと0が出たときに最初から面が揃っている・・・みたいなことが発生してしまうので、MAXノードを挟んで最低200回は回転するというようにしておきます。ループ中でどの方向に回転させるのかの判定用に真偽値をローカル変数で用意しておきます。

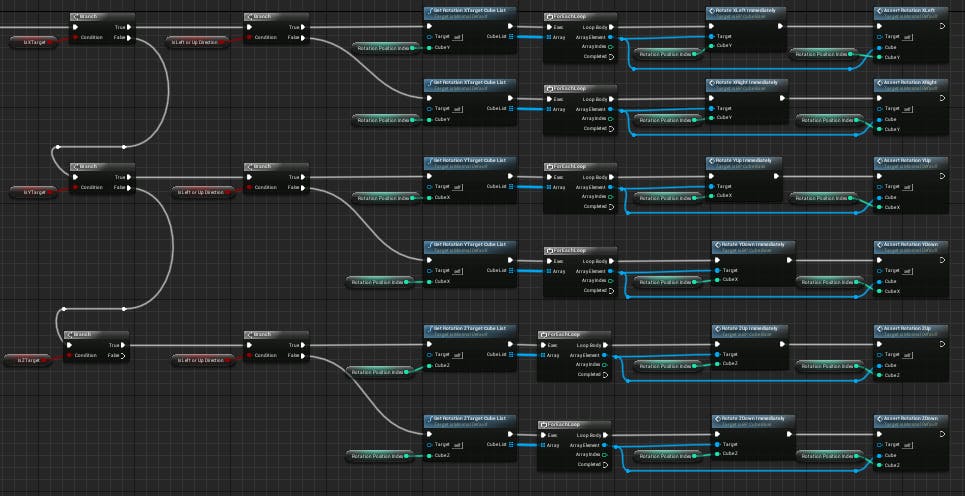

また、ループの先頭で一通りFalseにしておきます。まずはXYZどの方向に回転させるのかの真偽値でTrueにするものをランダムに決定します。

Switchノードをはじめて使ってみます。プログラミングに慣れていれば特に悩むことなく使える形でいいですね。続いて回転方向。左に回転させるのか右に回転させるのか、もしくは上に回転させるのか下に回転させるのかの対象をランダムに決定します。

最後に、どの列を回転させるのかといった値を算出します。1~3の値を算出する必要があるため、0~2までの値をRandom Integerノードで出してから1インクリメントしています。

後は、決定された値に応じてBranchで分岐させて必要な回転を実行させて完了です。

動かしてみます。

いい感じに色がばらけました。どんな感じに回転させれば色が全面揃うのかいまいち分かりませんね・・・。

もう一度実行してみます。

ちゃんとさっきとは異なる感じになっています。大丈夫そうですね。

ループがかなり多い処理ではありますが、私のデスクトップ環境では一瞬で終わるのと、特にFPS維持しないといけないとかでもないですし、そもそも学習で強化学習動かす方はデスクトップでしょうしそれなりに良いスペックのPCの方が大半でしょうから問題ないと判断します。回転中かどうかの真偽値の取得処理を用意する

アニメーション中に別の回転の回転が実行されると困ります。

最終的にはPython側でエラー制御などしようと思いますが、とりあえずブループリント上での実装を追加し、そちらと連携する形でPythonのコードを書いていきます。名前はGymライブラリの用語に準じてBP_Actionという名前のPyActorを継承したブループリントで作っていきます。

※Gymライブラリ回りの単語に関しては強化学習入門#1 基本的な用語とGym、PyTorch入門とかをご確認ください。ブループリントを追加したはいいものの、そういえばレベルに配置されているアクターってどう取得するんだ・・?と思ったところ、公式のドキュメントで書かれていました。

Get All Actors Of Classノードでいけそうですので試してみます。

シンプルにループで回して名前を画面にprintするだけのノードです。

ちゃんと表示されています。お手軽。

これを使えば、BP_Actionのブループリント内で、回転中のキューブのアクターが存在するかどうかの値を取るための関数が用意できそうです。

BP_CubeBaseの基底クラスのブループリントに、isRotatingという関数を追加します。

各回転方向で対象の回転の真偽値を取得する関数は以前用意していたので、そちらを呼び出しつつ、ローカル変数で真偽値の配列を用意して配列を統合いていきます。

配列に対する配列の追加はAPPENDノードでできるようです(Pythonでいうところのextend的な挙動)。一通りの真偽値が配列に追加し終わったら、配列を渡してその配列でいずれかの真偽値がTrueならTrueが返ってくる関数を以前別の箇所で用意して使っていた(そちらは配列が3件とかで指定していましたが・・・)ので、そちらを利用します。

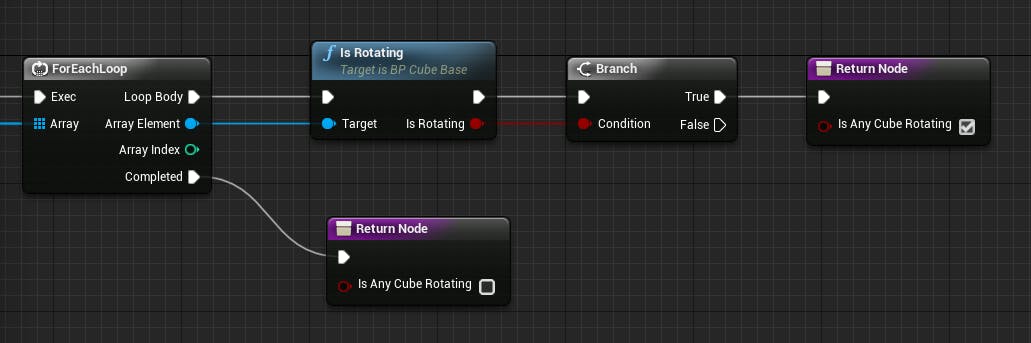

BP_ActionのブループリントにisAnyCubeRotatingという名前の関数で作っていきます。

少し前に触れたGet All Actors Of Classを使って配列を取得し、ループで回します。

ループ中で回転しているキューブがあればTrueのReturn Nodeへ、もし1つも回転しているものが見つからないままループが終わったらFalseのReturn Nodeへ流すようにします。

また、BP_Actionのブループリントで、Pythonのモジュールとクラスの指定をしておきます。

Python側でaction.pyというモジュールを追加して、処理を書いていきます。

まだPython側から回転の処理などを書いていないので、テストなどは一旦スキップします(機能テスト関係が整備してあればもう書くのですが、整備してないのとUE4関係のものはよく分かっていないので)。また、tickでコンソール出力を試してみます(今のところは必ずFalseが返るはず)。Content\Scripts\action.py"""Agentにおける何らかの行動制御に関連した処理を記述したモジュール。 """ import unreal_engine as ue class Action: def tick(self, delta_time): """ ゲームPlay中、約1フレームごとに実行される関数。 Parameters ---------- delta_time : float 前回のtick呼び出し後からの経過秒。 """ ue.log(is_any_cube_rotating(action_instance=self)) def is_any_cube_rotating(action_instance): """ いずれかのキューブが回転中かどうかの真偽値を取得する。 Parameters ---------- action_instance : Action uobjectを持ったActionクラスのインスタンス。 Returns ---------- is_rotating : bool いずれかのキューブが回転中であればTrueが設定される。 """ is_rotating = action_instance.uobject.isAnyCubeRotating()[0] return is_rotatingログを見るとFalseが出力されていることが分かります。

... LogPython: False LogPython: False LogPython: False LogPython: False ...とりあえずは大丈夫そうですね。コンソール出力を消しておいて、どんどん次にいきます。

NumPyを入れておく

hdf5関係をアンインストールした際に、dependenciesとしてインストールされたNumPyも一緒にアンインストールしてしまいましたが、やっぱり使いたいところが出てきたためNumPyのみ入れておきます。

$ ./python.exe -m pip install --target . numpySuccessfully installed numpy-1.17.3Action関係の制御の実装を進める。

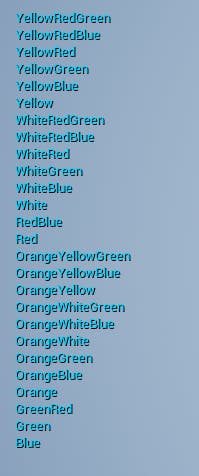

まずはとりあえずActionの番号の割り振りを定義しました。

重複やリストにちゃんと含まれているかなどはチェックされるようにしておきます。Content\Scripts\action.pyimport numpy as np ... ACTION_ROTATE_X_LEFT_1 = 1 ACTION_ROTATE_X_LEFT_2 = 2 ACTION_ROTATE_X_LEFT_3 = 3 ACTION_ROTATE_X_RIGHT_1 = 4 ACTION_ROTATE_X_RIGHT_2 = 5 ACTION_ROTATE_X_RIGHT_3 = 6 ACTION_ROTATE_Y_UP_1 = 7 ACTION_ROTATE_Y_UP_2 = 8 ACTION_ROTATE_Y_UP_3 = 9 ACTION_ROTATE_Y_DOWN_1 = 10 ACTION_ROTATE_Y_DOWN_2 = 11 ACTION_ROTATE_Y_DOWN_3 = 12 ACTION_ROTATE_Z_UP_1 = 13 ACTION_ROTATE_Z_UP_2 = 14 ACTION_ROTATE_Z_UP_3 = 15 ACTION_ROTATE_Z_DOWN_1 = 16 ACTION_ROTATE_Z_DOWN_2 = 17 ACTION_ROTATE_Z_DOWN_3 = 18 ACTION_LIST = [ ACTION_ROTATE_X_LEFT_1, ACTION_ROTATE_X_LEFT_2, ACTION_ROTATE_X_LEFT_3, ACTION_ROTATE_X_RIGHT_1, ACTION_ROTATE_X_RIGHT_2, ACTION_ROTATE_X_RIGHT_3, ACTION_ROTATE_Y_UP_1, ACTION_ROTATE_Y_UP_2, ACTION_ROTATE_Y_UP_3, ACTION_ROTATE_Y_DOWN_1, ACTION_ROTATE_Y_DOWN_2, ACTION_ROTATE_Y_DOWN_3, ACTION_ROTATE_Z_UP_1, ACTION_ROTATE_Z_UP_2, ACTION_ROTATE_Z_UP_3, ACTION_ROTATE_Z_DOWN_1, ACTION_ROTATE_Z_DOWN_2, ACTION_ROTATE_Z_DOWN_3, ] ... def test_ACTION_LIST(): assert_equal( len(ACTION_LIST), len(np.unique(ACTION_LIST)) ) members = inspect.getmembers(sys.modules[__name__]) for obj_name, obj_val in members: if not obj_name.startswith('ACTION_ROTATE_'): continue assert_true(isinstance(obj_val, int)) is_in = obj_val in ACTION_LIST assert_true(is_in) python_test_runner.run_tests( ue=ue, target_module=sys.modules[__name__])定義した定数名に準じて、BP_Actionに各アクションの関数を追加していきます。

と思ったものの、回転で対象となるキューブのリストを算出する関数がレベルのブループリントに書いてしまっていました。

BP_Actionからその関数を呼び出すのが大分面倒そうな印象があります・・やらかした感が・・・(慣れるまでこの参照ができないという点でついやらかしてしまう・・・)

参考 : レベルブループリントを参照する方法を考える嘆いていてもしょうがないので、キューブの基底クラスのブループリントに、各回転で対象となるキューブかどうかの真偽値を取得する関数を先に追加していきます(そうすればレベル内のキューブはGet All Actors Of Classノードで取れるので・・)。

関数ライブラリを試してみる

続きを進める前に、assertのヘルパー的なものなどをレベルのブループリントに書いていましたが、それだとBPクラスで使えなかったりで不便に感じる時があるので、調整を考えます。

調べてみると、どうやら関数ライブラリというものがあるようです。

関数ライブラリとは

どこからでもアクセスできる色んな関数を一か所にまとめて持つことができるブループリントです。

通常のブループリントと違い、変数を保持することができず、イベントグラフも存在しません。マクロも作れず、関数のみ作成可能です。

この中に書いた関数は、どのブループリント、それこそアクターやレベル問わず使えるようになります。

[UE4] 関数ライブラリとマクロライブラリの上手な活用作り方は以下の記事で書かれていました

UE4 汎用関数の作成(Blueprint Function Library)

慣習として、関数ライブラリのフォルダはどんな名前がいいのでしょう・・・?

動画や書籍で、ブループリントはBluePrints、ファイル名は先頭にBP_と付けましょうとか、マテリアルはMaterialsにしましょうとかそういった慣習が紹介されていましたが、関数ライブラリはどうだったか・・・そもそも関数ライブラリが紹介されていただろうか・・・(アウトプットしていないとすぐ忘れて良くないですね・・・)とりあえず、仕事ではないので気軽にLibrariesというフォルダ名にしておきましょうか。

ファイル名はLIB_とプリフィクス付けるようにしてみます。コンテンツブラウザで新規ファイルを追加し、Blueprints → Blueprint Function Libraryと選択すると作れるようです。

テスト関係を追加していきたいのでLIB_Testingという名前にしました。

開いてみたらこんな感じのようです。関数とローカル変数のみのごくシンプルな構成のブループリントみたいですね。

移しておきたい関数をこちらに移して、既存のレベルBP上の関数をそちらに差し替えておきます。ライブラリに追加した関数は、特に何もしないでもそのままレベルのBPやほかのBPクラスから呼び出せるようです。

これでBPクラス内でのライトな値のチェックなどもやりやすくなりました。

キューブの基底クラスに回転の対象かどうかの真偽値取得の処理を追加していく

前述のように、BP_CubeBaseの基底クラスから回転の対象かどうかの真偽値を取得できるようにし、BP_Actionから呼び出せるようにします。

以下のような真偽値を返す形の関数をXYZで1~3の範囲で作るので、関数を9個追加していきます。

共通部分は別の関数に切り分けてあります。また、対象の回転で対象となるキューブの位置の種別の配列は定数ですでに以前用意していたのでそちらを使っていきます。

共通処理の内部では、配列分ループを回して、

現在のキューブの位置の種別値が、現在のループでのインデックスの配列の値と一致する場合はTrue、ループ終わっても該当するものが無ければFalseを返すようにしています。

細かいところは省きますが、ある程度処理の挙動を確認するためのテストを書いておきます。

回転の9個分用意ができて、テストも引っかからない形になったので次へ進みます。

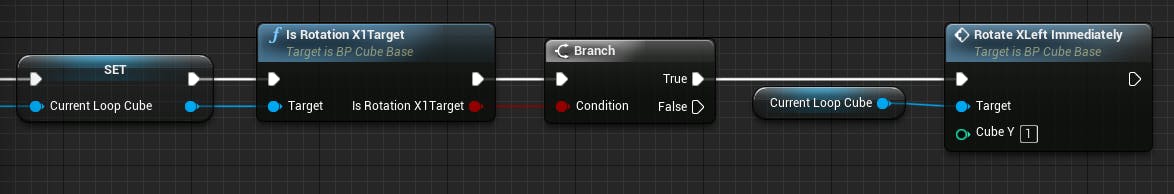

試しに1つ、BP_Actionに回転の関数を一つ追加してみます。まずはシンプルなアニメーションしないタイプの回転の方から進めていきます。まずはキューブのアクターを取得し、ループを回します。

後は先ほど用意した回転対象かどうかの真偽値での分岐を設けて、Trueなら回転するようにします。

Python側でも雑に試してみます。

Content\Scripts\action.pyclass Action: total_delta_time = 0 is_rotated = False def tick(self, delta_time): """ ゲームPlay中、約1フレームごとに実行される関数。 Parameters ---------- delta_time : float 前回のtick呼び出し後からの経過秒。 """ self.total_delta_time += delta_time if self.total_delta_time > 5 and not self.is_rotated: self.uobject.rotateXLeftImmediately1() self.is_rotated = Trueこれでとりあえず5秒後くらいに1回即時で回転します。

プレビューしてみましたが大丈夫そうです。

他の回転の処理も同様に組んでいきますが、その前に回転結果のテスト用の関数を、BP_Action側からも参照できるように関数ライブラリ側に移動させておき、レベル側の関数は置換して切り落としておきます。移動後、対象の回転後の値のチェック用の関数を今回BP_Actionに追加した関数の末尾に追加しておき、プレビューしてチェックに引っかからないことを確認しておきます。

とりあえず大丈夫そうなので、他の方向の回転なども一通り追加して、Python側から呼び出してみて動作確認しておきます。

Pythonを経由する即時の回転の処理は大丈夫そうです。

次回は、アニメーション付きの回転の処理をPythonに繋いでいく形で作業を進めていきます(記事が長くなってきたので、今回の記事はこの辺りにしておこうと思います)。気になった点

- たまに、Pythonスクリプトの更新が反映されないことがありました(UE4再起動すると直る)。Pythonプロセスが起動したままになるので、長時間そのままだと色々不整合的にうまく処理が通らない・・・みたいなケースに悩まされました。importlibとか使っても直らないケースが・・・。起動にそこまで時間がかかるというものでもないですか、少々気になりますね・・・。いい感じの方法無いだろうか・・・(後でUnrealEnginePythonのプラグインのgithubのissueとか漁ってみてもいいかもと考えています・・)

参考ページまとめ

- 投稿日:2019-11-12T21:01:00+09:00

ちょっとブログ感覚でじぶんが触れたことあるものまとめ

python

flask

pythonのwebアプリケーション用ライブラリ。

プロトコル通信での送受信を結構簡単に行える。受信した数値に対してpython側で計算をしたり、表にまとめるなどできる。インスタグラムなどの大規模なシステム構築には向かないらしい。しかし、簡単なウェブアプリケーションを作るうえでは問題ない。

正確な情報や不正確な情報が蔓延しているので、実際に実装して確かめる必要がある。ポート開放の知識が必要。http://python.zombie-hunting-club.com/entry/2017/11/03/223503

flaskの使い方の初歩はここから学んだ。https://qiita.com/keimoriyama/items/7c935c91e95d857714fb

https://qiita.com/5zm/items/ac8c9d1d74d012e682b4

【クラインアント→サーバー】クライアントからファイルを貰う方法の参考に。https://qiita.com/5zm/items/760000cf63b176be544c

【サーバー→クラインアント】プロトコル通信使って、クライアントにファイルを投げる方法の参考に。matplotlib,sympy

ふと思い立って、グラフ描画をしたくなったときのやつ。

matplotlibは描画用ライブラリ、sympyはシミュレーション用ライブラリ。なんかよくはわからんけど、二つとも使う。https://qiita.com/HigashinoSola/items/2ab8894b543e0c55cfa7

このページはうまくまとめられているので初心者向けによい。https://qiita.com/orange_u/items/8a1e285a45093857aef7

3D描画する際に参考にした。https://matplotlib.org/3.1.0/gallery/mplot3d/text3d.html

3D描画にテキストを記述する方法。上のページ内にも書いてあるが、import matplotlib.pyplot as plt fig=plt.figure() ax=Axes3D(fig) ax.text(x,y,z,Text,dir) #x,y,zは座標、Textはstr型の文字、dirは(x,y,z)でカメラに対してのアングル

- 投稿日:2019-11-12T20:53:47+09:00

Django + Google Cloud Strageで、ImageFieldの画像をサーバでも正常に表示させる

HerokuやGAE(Google App Engine)などのサーバで、ImageFieldを使用しても画像が正常に表示されません。

これは、SQLが画像のアップロードに対応していないためで、これの解決にはGoogle Cloud StrageやAmazon S3などのクラウドストレージに画像をアップロードしなければなりません。

今回は、Google Cloud Storageに画像をアップロードする方法をご紹介します。

Django Strage (Google Cloud Storage) 公式ドキュメント

https://django-storages.readthedocs.io/en/latest/backends/gcloud.htmlDjango Strage のインストール

Django で Google Cloud Strage を扱うための Django ライブラリ、

Django Strage (Google Cloud Storage)をpipでインストールします。bash$ pip install django-storages[google]Google Cloud Platform で認証情報の取得

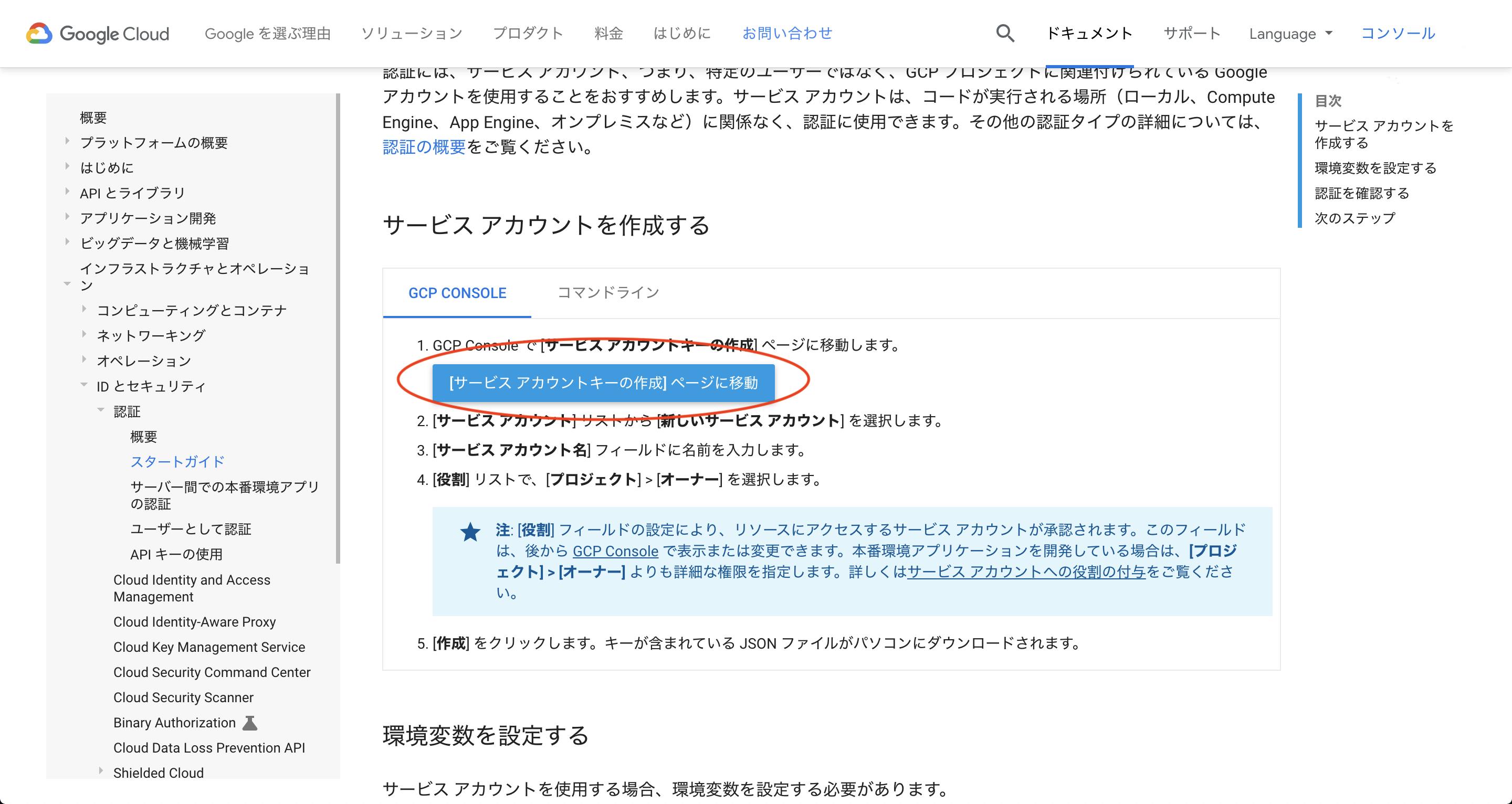

Google Cloud Platform から、 Cloud Strageの認証情報の登録と、認証情報の記載された JSON ファイルを取得します。

サービスアカウントの取得

Googleスタートガイド (https://cloud.google.com/docs/authentication/getting-started) から取得できます。

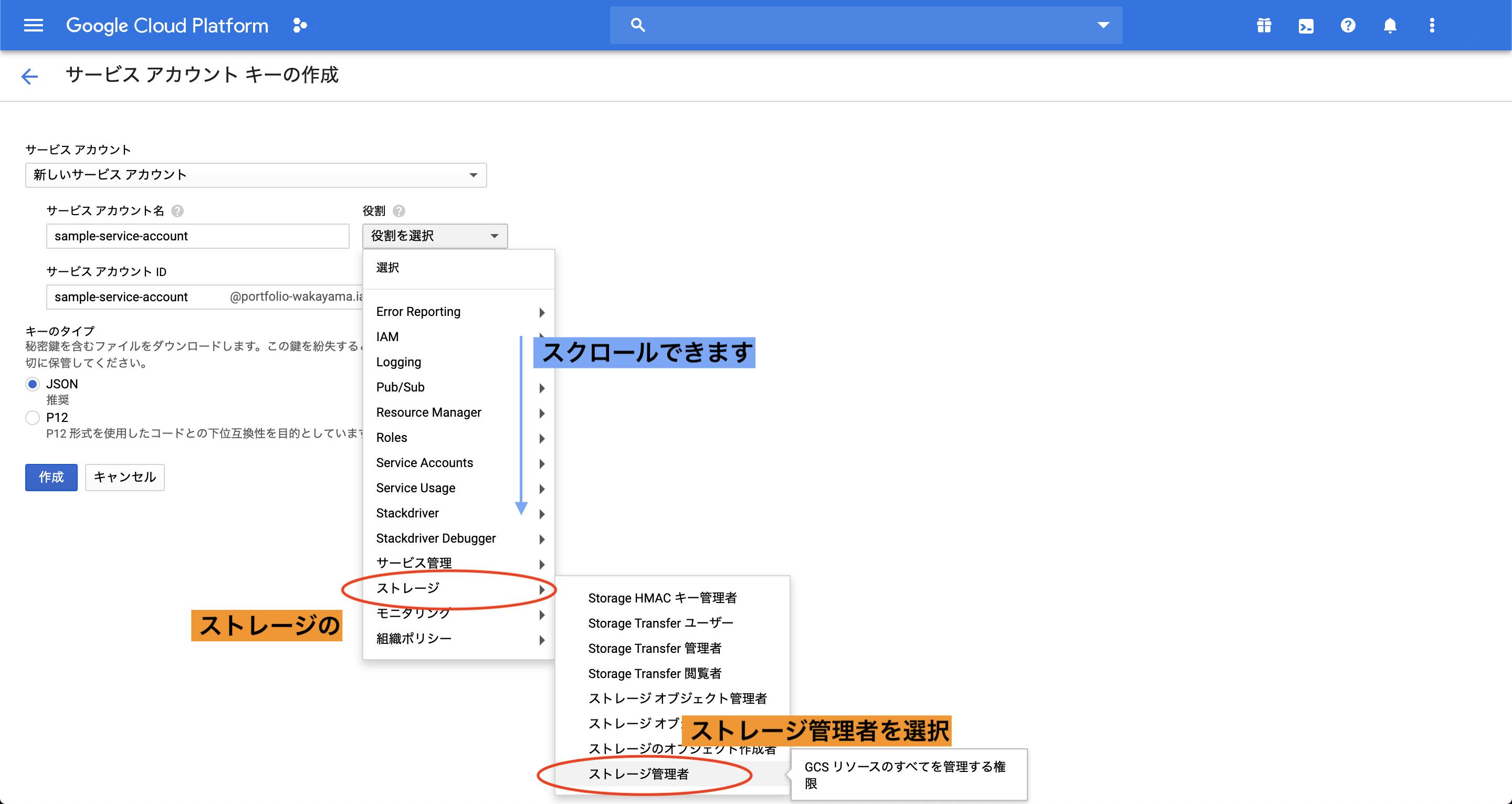

手順1

Googleスタートガイド (https://cloud.google.com/docs/authentication/getting-started) のリンクから、「[サービスアカウントキーの作成]ページに移動」を選択

手順2

新しいサービスアカウントを作成で、サービスアカウント名を入力。

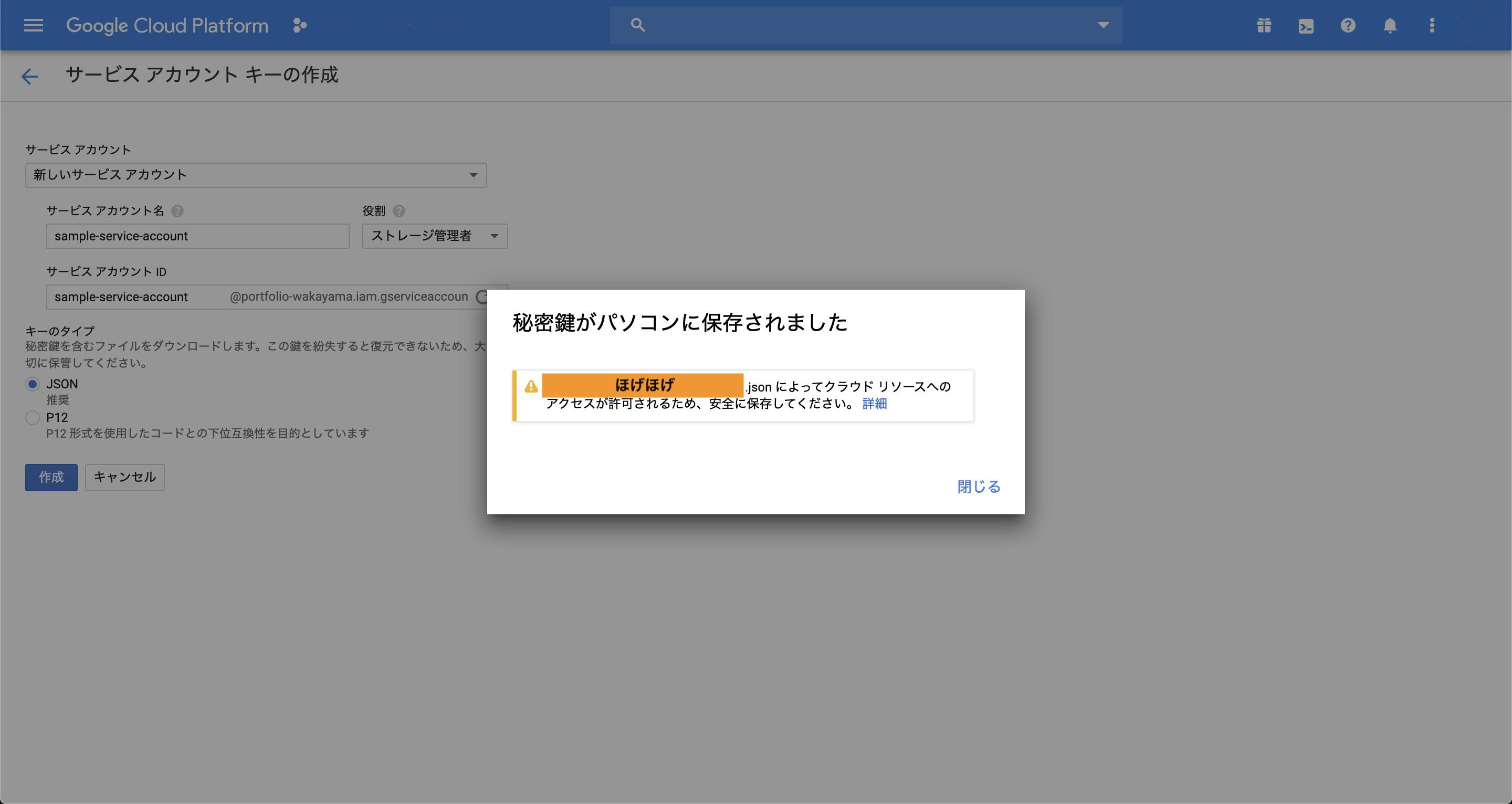

その後、役割から「ストレージ」 -> 「ストレージ管理者」を選択。

キーのタイプがJSONになっていることを確認して、「作成」ボタンを押下してください。

そうすると、JSONファイルがダウンロードされます。

ダウンロードしたJSONファイルは、Djangoプロジェクトのルートディレクトリに配置してください。

Google Cloud Strageのバケットの作成

Cloud Strageの単位をバケットといいます(データを入れるバケツみたいな意味)

これを作成して、データを収納します。Google Cloud Console (Cloud Strage)

https://console.cloud.google.com/storage/browser上記URLからアクセスすると、以下のような作成画面に遷移すると思うので、新規バケットを作成します。

これで、Google Cloud Platform console での設定は完了です。

Djangoでの設定

settings.pyに設定の追加

settings.pyファイルでデフォルトのストレージとバケット名を設定します。

settings.pySTATIC_URL = '/static/' STATIC_ROOT = os.path.join(BASE_DIR, 'staticfiles') STATICFILES_STORAGE = 'storages.backends.gcloud.GoogleCloudStorage' MEDIA_URL = '/media/' MEDIA_ROOT = os.path.join(BASE_DIR, 'media') DEFAULT_FILE_STORAGE = 'storages.backends.gcloud.GoogleCloudStorage' GS_BUCKET_NAME = '[YOUR_BUCKET_NAME_GOES_HERE]' from google.oauth2 import service_account GS_CREDENTIALS = service_account.Credentials.from_service_account_file( os.path.join(BASE_DIR, '[YOUR_AUTHENTICATON_KEY_FILE_NAME].json'), )以上で設定は完了です。

あとは以下のコマンドを実行しましょう。

bash$ python manage.py collectstaticそして設定の変更をサーバにデプロイすると正常に機能するはずです。

お疲れ様でした。

- 投稿日:2019-11-12T20:48:04+09:00

OpenCVを使って長い動画を一部だけ保存する方法

きっかけ

グフ/増殖系YouTuber の 「NHK」で増えて「ぶっ壊す」で倍になる立花孝志 にsyncしました

ちょうど良い動画素材で、領域分割・顔認識・テロップを消すには・・・などなど何かしらでopencvで出来そうです。

この動画は18分あるのですが候補者が登場する冒頭の1分だけを使いたいと思っています。

で、一部分だけ時間によって抽出する方法をpythonとOpenCVのみでやってみます。元素材

方法

- 元動画からfps(1秒あたりのフレーム数)を抽出する

開始時間 * fpsor終了時間 * fpsでフレーム数を計算する

time.time()で計測しようとしたのですがフレーム数ベースで制御した方が成功しました。また、

候補者が登場する冒頭の1分なので

- 開始時間 = 30秒

- 終了時間 = 90秒

としました。

開発

import cv2 if __name__ == '__main__': cap = cv2.VideoCapture('drop_out_nhk.mp4') cap_width = int(cap.get(cv2.CAP_PROP_FRAME_WIDTH)) cap_height = int(cap.get(cv2.CAP_PROP_FRAME_HEIGHT)) fps = cap.get(cv2.CAP_PROP_FPS) fourcc = cv2.VideoWriter_fourcc('m','p','4','v') writer = cv2.VideoWriter('one_minutes.mp4',fourcc, fps, (cap_width, cap_height)) # 抽出したい開始or終了時間 begin = 30 end = 90 for i in range(end * fps): ret, frame = cap.read() if ret: if begin * fps < i: writer.write(frame) writer.release() cap.release()結果

多分これでちょうど1分になったと思います。

おわりに

asyncioとか使おうと思ったのですが、割とすんなり実装できました。 画像サイズを変えるとなぜかコーデックでミスります。参考にしたリンク

- 投稿日:2019-11-12T20:26:33+09:00

Python + ImageMagick > BMP形式の文字一覧から文字を切り出す (東雲フォントのBMP変換に対して)

動作環境Ubuntu 16.04 LTS Python 3.5.2 ImageMagick 6.8.9-9 Q16 x86_64 2018-09-28概要

- 東雲フォント(BDF形式)をBMP形式に変換した

- BMP形式から各文字を切り出す

- 16x16のフォント

実装 v0.1

枠線は2ピクセル。

divide_191112.pyimport subprocess as sb import sys # on Python 3.5.2 # Ubuntu 16.04 LTS # cut out 16x16 bitmap fonts BORDER_WIDTH = 2 INFILE = "shnmk16.bmp" idx = 0 for lin in range(10): for col in range(32): idx = idx + 1 xpos = BORDER_WIDTH + (BORDER_WIDTH + 16) * col ypos = BORDER_WIDTH + (BORDER_WIDTH + 16) * lin aform = "convert %s -crop 16x16+%d+%d wrk-%03d.bmp" acmd = aform % (INFILE, xpos, ypos, idx) print(acmd) sb.getoutput(acmd)wrk-000.bmpのように文字ごとにファイルになる。

これを使ってanimated gifを作成できる。切り出したファイル

- wrk-148: 数値の始まり

- wrk-158: upper case英字の始まり

- wrk-184: lower case英字の始まり

- wrk-210: ひらがなの始まり

- wrk-293: カタカナの始まり

実装 v0.2

- 16x16を32x32へ

- imagemagickで画像のリサイズ by @tukiyo3 さん

- 情報感謝です。

- 白黒反転する

- カメラ写りが悪かったので

- Invert colors with ImageMagick

divide_191112.pyimport subprocess as sb import sys # on Python 3.5.2 # Ubuntu 16.04 LTS # cut out 16x16 bitmap fonts BORDER_WIDTH = 2 INFILE = "shnmk16.bmp" idx = 0 for lin in range(10): for col in range(32): idx = idx + 1 xpos = BORDER_WIDTH + (BORDER_WIDTH + 16) * col ypos = BORDER_WIDTH + (BORDER_WIDTH + 16) * lin # aform = "convert %s -crop 16x16+%d+%d wrk-%03d.bmp" # x 1 aform = "convert %s -crop 16x16+%d+%d -resize 32x32 -channel RGB -negate wrk-%03d.bmp" # x2 invert acmd = aform % (INFILE, xpos, ypos, idx) print(acmd) sb.getoutput(acmd)

- 投稿日:2019-11-12T19:40:00+09:00

Pythonで蟻本"Lake Counting"を解いてみた

ゆっくりだけど蟻本解いていきます。

今日はLake Counting。lake_counting.pydef lake_counting(lake): # 水たまりWの数を数える # 8近傍で隣接しているWは一つの水たまりとみなす # 文字列のlakeを配列に格納 def lake_to_list(lake): lake_list = [] lake = lake.split() for i in range(len(lake)): lake_list.append([]) for j in range(len(lake[0])): lake_list[i].append(lake[i][j]) return lake_list def dfs(lake_list, x, y): lake_list[y][x] = "." # Wの箇所を見つけたらその周り8か所を探索 # Wを見つけたら.に置き換える # これにより隣接しているWも含めた水たまりの数1カウントとできる for dx in range(-1, 2): for dy in range(-1, 2): nx = x + dx ny = y + dy if nx >= 0 and nx < len(lake_list[0]) and ny >= 0 and ny < len(lake_list): #隣接しているWがあればそのまた隣接も探索 if lake_list[ny][nx] == "W": dfs(lake_list, nx, ny) def main(): lake_cnt = 0 lake_list = lake_to_list(lake) # lake配列を順に探していってWを見つけたら # dfs関数が働く for y in range(len(lake_list)): for x in range(len(lake_list[0])): if lake_list[y][x] == "W": dfs(lake_list, x, y) lake_cnt += 1 print (lake_cnt) main()テストケース lake = """ W........WW. .WWW.....WWW ....WW...WW. .........WW. .........W.. ..W......W.. .W.W.....WW. W.W.W.....W. .W.W......W. ..W.......W. """ lake_counting(lake) #出力:3

- 投稿日:2019-11-12T19:22:23+09:00

CNNを用いた画像認識 馬と鹿

はじめに

初めての機械学習を行う際に、画像認識に興味があり、やってみようと思ったのですが、どういったアプローチにしようか迷っていました。

そこで、Aidemyの「CNNを用いた画像認識」というコースがあったので、それを受講し、CNNをやることにしました。最初に考えたのが、競馬が好きなので競走馬の分類。

【競走馬 = 騎手が乗っている馬】として考えて、競争馬でも裸馬でも、【馬】として認識できるものを作ろうと考えました。分類は馬と鹿にしました。

理由は、馬の画像収集の過程でCIFAR-10のデータセットも使わさせて頂いたのですが、CIFAR-10の中にdeer(鹿)があったからです。

動物として似ているものに挑戦してみたかったので、ちょうど良かったです。TODO

- 画像収集

- 収集画像の処理

- 画像の水増し

- 画像を学習/検証データにする

- モデル構築と保存

- 結果のグラフ化

- 別の画像でテスト

画像収集

画像収集には、以下を利用しました。

- Google Images Download

- bing_image_downloader API

検索ワード「競走馬」「Race horse」「Cheval de course」 約1400枚

検索ワード「鹿」約800枚

- データセット

- CIFAR-10のhorse 1001枚

- CIFAR-10のdeer 999枚

収集画像の処理

データセットは完璧に処理済みなので、Webから拾ってきた画像を処理します。

1.重複画像の削除

image hash(phash)を利用して、重複画像を抽出します。

ImageHashで同じ画像を持つフォルダを検出する

こちらのコードを引用、編集したものを使いました。from PIL import Image, ImageFile import imagehash import os # サイズの大きな画像をスキップしない ImageFile.LOAD_TRUNCATED_IMAGES = True # phash 2つの画像のハッシュ値の差分を出力 def image_hash(img, otherimg): # phashを指定 hash = imagehash.phash ( Image.open ( img ) ) other_hash = imagehash.phash ( Image.open ( otherimg ) ) return hash - other_hash # 画像サイズの小さい方を検出する def minhash(img, otherimg): # (幅, 高さ)のタプル hash_size = Image.open ( img ).size otherhash_size = Image.open ( otherimg ).size if hash_size == otherhash_size: return 0 if hash_size < otherhash_size: return 1 # 以下のパスに調べてほしい画像の入ったディレクトリを保存 default_dir = '画像の入ったディレクトリを保存したパス' # 調べてほしい画像の入ったディレクトリを取得 img_dir = os.listdir ( default_dir ) # 調べてほしい画像の入ったパスを取得 img_dir_path = os.path.join ( default_dir, img_dir[0] ) # 画像のリストを取得 img_list = os.listdir ( img_dir_path ) # 画像が2枚以上あれば、画像のパスを取得してリスト化 img_path = [os.path.join ( img_dir_path, i ) for i in img_list if len ( os.path.join ( img_dir_path, i ) ) > 2] # フォルダ内の画像の数の取得 img_list_count = len ( img_list ) i = 0 delete_list = [] # image_hash(),minhash()でフォルダごとの画像を比較 while i < img_list_count: # 進捗状況 print ( '実行中 : ', str ( i + 1 ) + '/' + str ( img_list_count ) ) # i + 1 で2回目の比較のものと、同じ画像の比較をしない for j in range ( i + 1, img_list_count ): # ハッシュ値の差分が10以下なら同一の画像として認識 if image_hash ( img_path[i], img_path[j] ) < 10: print ( img_path[i] + ' | vs | ' + img_path[j] ) # 画像サイズが同じだった場合片方のパスをdelete_listに格納 if minhash ( img_path[i], img_path[j] ) == 0: if not img_path[j] in delete_list: delete_list.append ( img_path[i] ) # 画像サイズの小さい方のパスをdelete_listに格納 if minhash ( img_path[i], img_path[j] ) == 1: delete_list.append ( img_path[i] ) j += 1 i += 1 # 削除したい画像パスの表示 print ( delete_list ) # 削除したい画像を開く場合 # def open_folder(path): # subprocess.run ( 'explorer {}'.format ( path ) ) # # for i in range ( len ( delete_list ) ): # open_folder ( delete_list[i] ) # 続けて削除したい場合 # for i in delete_list: # try: # os.remove( i ) # except OSError : # pass参考文献

pythonを使ってORBとPerceptual Hashで画像の類似度を比べてみる

Perceptual Hashを使って画像の類似度を計算してみる

2.関係ない画像の削除、そして画像をRGB形式に変換

学習に使用できないと思われる画像を、手動で削除しました。

RGB形式への変換はこちらを参考にさせて頂きました。

機械学習用に画像を前処理するこうして処理済みの画像を用意できました。

- horseフォルダ 約1400枚 → 計438枚

- deerフォルダ 約800枚 → 計139枚

上記の画像にプラスCIFAR-10の画像を使います。

画像の水増し

horseフォルダ APIで拾った459枚、

deerフォルダ API + CIFAR-10

1138枚

をImageDataGeneratorで水増しします。fit_generator()、flow()を使用してそのままモデルを訓練できますが、今回は単純な水増しが目的です。

ですので、生成した画像を自身のドライブに保存します。

from keras.preprocessing.image import ImageDataGenerator import os datagen = ImageDataGenerator(rotation_range=20, # ランダムに回転する回転範囲(単位degree) width_shift_range=0.2, # ランダムに水平方向に平行移動する、画像の横幅に対する割合 height_shift_range=0.2, # ランダムに垂直方向に平行移動する、画像の縦幅に対する割合 shear_range=0.2, # せん断の度合い。大きくするとより斜め方向に押しつぶされたり伸びたりしたような画像になる(単位degree) zoom_range=0.2, # ランダムに画像を圧縮、拡大させる割合。最小で 1-zoomrange まで圧縮され、最大で 1+zoom_rangeまで拡大される horizontal_flip=True) # ランダムに水平方向に反転 root_dir = './data/padding' # 水増ししたい画像フォルダのあるパス targetsize = (128, 128) # 加工サイズ save_dir = os.listdir(root_dir) # 水増しした画像を保存するフォルダ名 save_path = os.path.join('./data/save', save_dir[0]) # 水増しした画像の保存先 increase = len(os.listdir(os.path.join(root_dir, save_dir[0]))) # 水増ししたい画像フォルダに入っている画像の数 increase_count = 1 # 1枚につき、このパターン数だけ水増し(increase✕increase_countの数だけ画像が増える) # 保存先ディレクトリが存在しない場合、作成 if not os.path.exists(save_path): os.makedirs(save_path) # flow_from_directory()で水増ししたい画像(フォルダ)の取得と、水増しした画像の加工と保存を同時におこなう ffd = datagen.flow_from_directory( directory=root_dir, target_size=targetsize, color_mode='rgb', batch_size=increase, save_to_dir=save_path) [next(ffd) for i in range(increase_count)]

horseフォルダ 2000枚

deerフォルダ 2000枚

が用意できました。参考文献

Keras - Keras の ImageDataGenerator を使って学習画像を増やす

Keras CNN を改造してImageDataGenerator(画像水増し機能)を理解する

classifier_from_little_data_script_1.py

KerasのImageDataGeneratorで学習用画像を水増しする方法

Image Preprocessingインポート

「結果のグラフ化」までのインポートは以下の通り

# plaidMLをKarasで動かすためのコード import plaidml.keras plaidml.keras.install_backend() from sklearn.model_selection import train_test_split from keras.callbacks import ModelCheckpoint from keras.layers import Conv2D, MaxPooling2D, Dense, Dropout, Flatten from keras.models import Sequential from keras.utils import np_utils from keras import optimizers from keras.preprocessing.image import img_to_array, load_img import keras import glob import numpy as np import matplotlib.pyplot as plt画像を学習/検証データにする

- 画像サイズを全て統一

- 配列化

- 学習データ8割、検証データ2割の割合で分ける

# 画像ディレクトリのパス root_dir = './data/' # 画像ディレクトリ名 baka = ['horse', 'deer'] X = [] # 画像の2次元データを格納するlist y = [] # ラベル(正解)の情報を格納するlist for label, img_title in enumerate(baka): file_dir = root_dir + img_title img_file = glob.glob(file_dir + '/*') for i in img_file: img = img_to_array(load_img(i, target_size=(128, 128))) X.append(img) y.append(label) # Numpy配列を4次元リスト化(*, 244, 224, 3) X = np.asarray(X) y = np.asarray(y) # 画素値を0から1の範囲に変換 X = X.astype('float32') / 255.0 # ラベルをOne-hotにしたラベルに変換 y = np_utils.to_categorical(y, 2) # データを分ける X_train, X_test, y_train, y_test = train_test_split( X, y, test_size=0.2, random_state=0) xy = (X_train, X_test, y_train, y_test) # .npyで保存 np.save('./npy/train.npy', xy) # 学習用の画像データ(行(高さ), 列(幅), 色(3))の確認(入力層input_shapeと同じ) print('3次元 :', X_train.shape[1:])モデル構築と保存

ここの部分は試行錯誤

model.fit()のcallbacksでModelCheckpointを使用して、エポック毎にmodelを保存します。

最終的に、val_lossが最小値の時のmodel全体が、hdf5形式で残ります。

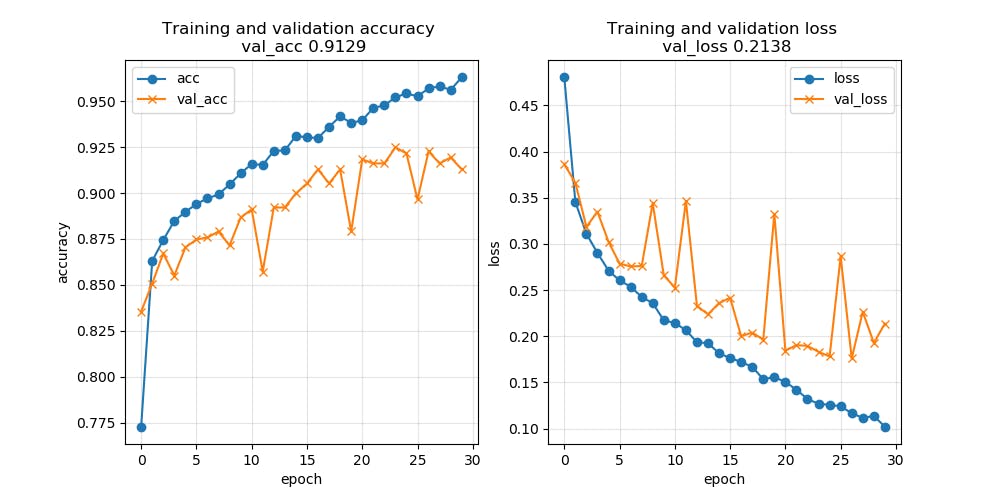

モデル、グラフは最終的なテストで一番正解率が高かったものを載せます。# 入力層,隠れ層(活性化関数:relu) model.add ( Conv2D ( 32, (3, 3), activation='relu', padding='same', input_shape=X_train.shape[1:] ) ) model.add ( MaxPooling2D ( pool_size=(2, 2) ) ) model.add ( Conv2D ( 32, (3, 3), activation='relu', padding='same' ) ) model.add ( MaxPooling2D ( pool_size=(2, 2) ) ) model.add ( Conv2D ( 64, (3, 3), activation='relu' ) ) model.add ( MaxPooling2D ( pool_size=(2, 2) ) ) model.add ( Conv2D ( 128, (3, 3), activation='relu' ) ) model.add ( MaxPooling2D ( pool_size=(2, 2) ) ) model.add ( Flatten () ) model.add ( Dense ( 512, activation='relu' ) ) model.add ( Dropout ( 0.5 ) ) # 出力層(2クラス分類)(活性化関数:softmax) model.add ( Dense ( 2, activation='softmax' ) ) # コンパイル(学習率:1e-3、損失関数:categorical_crossentropy、最適化アルゴリズム:RMSprop、評価関数:accuracy(正解率)) rms = optimizers.RMSprop ( lr=1e-3 ) model.compile ( loss='categorical_crossentropy', optimizer=rms, metrics=['accuracy'] ) # 学習モデルのエポック epoch = 50 # モデルを保存するパス fpath = f'./model/model.{epoch:02d}-.h5' # エポックごとにモデルを保存するかチェック mc = ModelCheckpoint ( filepath=fpath, monitor='val_loss', # 評価をチェックする対象 verbose=1, save_best_only=True, # val_lossの最新の最適なモデルは上書きされない save_weights_only=False, # Falseの場合モデル全体が保存 mode='min', # チェックの対象がval_lossなので最小を指定 period=1 ) # チェックするエポックの間隔 # 構築したモデルで学習 history = model.fit ( X_train, y_train, batch_size=64, epochs=epoch, callbacks=[mc], validation_data=(X_test, y_test) )結果のグラフ化

グラフに表示される数値はmodel.h5の数値ではなく、最後のエポックの数値になります。

# 可視化 fig = plt.figure(figsize=(18, 6)) # ウィンドウ作成 # 正解率グラフ plt.subplot(1, 2, 1) # 2つ横に並べて右側に表示 plt.plot(history.history['acc'], label='acc', ls='-', marker='o') # 学習用データのaccuracy plt.plot(history.history['val_acc'], label='val_acc', ls='-', marker='x') # 訓練用データのaccuracy plt.title(f'Training and validation accuracy \n val_acc {score[1]:.4f}') # タイトル plt.xlabel('epoch') # 横軸 plt.ylabel('accuracy') # 縦軸 plt.legend(['acc', 'val_acc']) # 凡例 plt.grid(color='gray', alpha=0.2) # グリッド表示 # 損失グラフ plt.subplot(1, 2, 2) # 2つ横に並べて左側に表示 plt.plot( history.history['loss'], label='loss', ls='-', marker='o') # 学習用データのloss plt.plot(history.history['val_loss'], label='val_loss', ls='-', marker='x') # 訓練用データのloss plt.title(f'Training and validation loss \n val_loss {score[0]:.4f}') plt.xlabel('epoch') plt.ylabel('loss') plt.legend(['loss', 'val_loss']) plt.grid(color='gray', alpha=0.2) # 保存 plt.savefig('1.png') plt.show()保存されたモデル

Epoch 15/50

・・・・・・

3200/3200 [==============================] - 122s 38ms/step - loss: 0.1067 - acc: 0.9625 - val_loss: 0.1872 - val_acc: 0.9363グラフに安定感がないため、

Epoch15がval_loss最小値になりました。

val_loss: 0.1872 - val_acc: 0.9363学習率が高いことや、データ数が少ないことが考えられ、

また後半は過学習を起こしています。これをもとに改善したことを、この記事の終わりの方の「試してみたこと」に記載しました。結果的にダメでしたが……

別の画像でテスト

# plaidMLをKarasで動かすためのコード import plaidml.keras plaidml.keras.install_backend() from keras.preprocessing.image import img_to_array, load_img from keras.models import load_model import numpy as np import glob # モデルデータのパス hdf_path = './model/model.20-val_loss 0.2648 - val_acc 0.8793.h5' # モデル読み込み model = load_model(hdf_path) # テストする画像が入っているディレクトリ img_path = './baka/' # 14枚の画像取得 img_list = glob.glob(img_path + '*') size = (128, 128, 3) for index, i in enumerate(img_list): # 画像をサイズを変えて読み込み、配列化 test_img = img_to_array(load_img(i, target_size=size)) # 0~1の範囲にする test_img = test_img / 255 # 4次元配列に test_img = test_img[np.newaxis, ...] # 予測 pre = model.predict(test_img) if np.max(pre[0]) == pre[0, 0]: print(f'{img_list[index]} -> {pre} は 馬') if np.max(pre[0]) == pre[0, 1]: print(f'{img_list[index]} -> {pre} は 鹿')配列の左側の数字が高いと馬、右側の数字が高いと鹿です。

deer1.jpg -> [[0.08649362 0.9135064 ]] は 鹿

deer2.jpg -> [[5.096481e-06 9.999949e-01]] は 鹿

deer3.jpg -> [[0.01137464 0.9886254 ]] は 鹿

deer4.jpg -> [[0.04577665 0.9542234 ]] は 鹿

deer5.jpg -> [[1.0562457e-07 9.9999988e-01]] は 鹿

deer6.jpg -> [[0.10744881 0.89255124]] は 鹿

deer7.jpg -> [[0.5856648 0.41433516]] は 馬

horse1.jpg -> [[0.00249346 0.99750656]] は 鹿

horse10.jpg -> [[0.6968936 0.30310643]] は 馬

horse2.jpg -> [[0.90138936 0.09861059]] は 馬

horse3.jpg -> [[9.9987268e-01 1.2731158e-04]] は 馬

horse4.jpg -> [[9.9999964e-01 4.1403896e-07]] は 馬

horse5.jpg -> [[9.999294e-01 7.052123e-05]] は 馬

horse6.jpg -> [[9.9999738e-01 2.6105645e-06]] は 馬

horse7.jpg -> [[0.93193245 0.06806755]] は 馬

horse8.jpg -> [[0.01251398 0.987486 ]] は 鹿

horse9.jpg -> [[0.00848716 0.99151284]] は 鹿正解率は76.47%でした。

一番の目的であった、競走馬の判定としてはhorse10.jpgは【馬】判定でしたが、horse8.jpg、horse9.jpgは【鹿】判定でした。

原因はデータセットにあるのか、データサイズにあるのか、それとも全然別にあるのか、勉強がまだまだ足りないことを思い知りました。

試したことの一部を載せます。

試したことその1

データセットを変更

- horseフォルダの変更

- 競走馬の正面からの写真を21枚増やす

- 計459枚を水増したものだけをhorseフォルダに入れる (CIFAR-10のhorse 1001枚を使わない)

- horseフォルダに合わせてdeerフォルダを水増し (こちらはCIFAR-10のdeer 999枚を使っている)

horseフォルダ → 2295枚

deerフォルダ → 2295枚

そして、層などは変えませんでしたが、学習率を1e-4に下げました。

Epoch 27/30

・・・・・・

3672/3672 [==============================] - 139s 38ms/step - loss: 0.1167 - acc: 0.9570 - val_loss: 0.1760 - val_acc: 0.9227グラフが安定していません

テスト結果不正解

deer1.jpg -> [[0.5788138 0.42118627]] は 馬

deer5.jpg -> [[0.5183205 0.48167947]] は 馬

horse8.jpg -> [[0.0699899 0.93001 ]] は 鹿

正解

horse9.jpg -> [[0.612066 0.38793397]] は 馬

horse10.jpg -> [[0.7463752 0.2536248]] は 馬正解率70.59%、下がってしまいました。

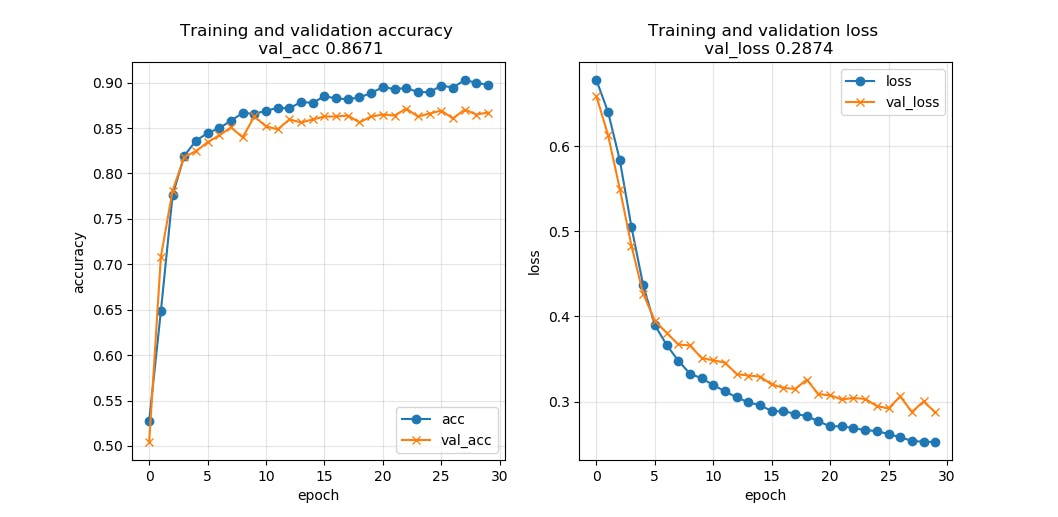

試したことその2

今度は学習率を1e-5まで更に下げ、バッチサイズを32にしました。層などは変えていません。

グラフは安定傾向になりました。

しかし、テストの正解率は47.06%、かなり下がってしまいました。試したことその3

上記のデータセットで他にもいろいろ試しましたが、期待する結果が得られなかったため、再度データセットを変更しました。

- horseフォルダの変更

- 使用していなかったCIFAR-10のhorse 1001枚を使う ただし、水増しはWebから拾った方だけ(459枚→1275枚)

- deerフォルダは特に変更なし、数を合わせただけ

horseフォルダ → 2276枚

deerフォルダ → 2276枚また、層を減らしました

# 入力層,隠れ層(活性化関数:relu) model.add ( Conv2D ( 32, (3, 3), activation='relu', padding='same', input_shape=X_train.shape[1:] ) ) model.add ( MaxPooling2D ( pool_size=(2, 2) ) ) model.add ( Conv2D ( 32, (3, 3), activation='relu', padding='same' ) ) model.add ( MaxPooling2D ( pool_size=(2, 2) ) ) model.add ( Conv2D ( 64, (3, 3), activation='relu' ) ) model.add ( MaxPooling2D ( pool_size=(2, 2) ) ) model.add ( Flatten () ) model.add ( Dense ( 64, activation='relu' ) ) model.add ( Dropout ( 0.5 ) ) # 出力層(2クラス分類)(活性化関数:softmax) model.add ( Dense ( 2, activation='softmax' ) )コンパイル(学習率:1e-4、損失関数:categorical_crossentropy、最適化アルゴリズム:RMSprop、評価関数:accuracy(正解率))

エポック epochs=20、バッチサイズ batch_size=32

Epoch 18/20

3641/3641 [==============================] - 131s 36msstep - loss 0.2647 - acc 0.8846 - val_loss 0.2948 - val_acc 0.8716グラフは若干安定傾向ですが、テストの正解率は64.71%でした。

テスト画像からみる考察

シグモイド関数なども含め、いろいろ試しましたが、

deer1.jpgは馬と判定される確率高いです。

それ以上にhorse8.jpg、horse9.jpgの競走馬正面画像が鹿と判定されやすいです。

データが足りないかもしれません。おわりに

正解率を上げるためには、まだまだいろいろな技術がありますが、一度ここで終えて、またチャレンジしたいと思います。学習率減衰、アンサンブル学習、転移学習、EfficientNetなどなど。

自分の理想とする結果は得られませんでしたが、CNNを用いた画像認識を行ってみることはできました。

参考文献

Kerasで2種類(クラス)への分類

CNNの学習に最高の性能を示す最適化手法はどれか

バレンタインデーにもらったチョコが本命かどうか判定するAIを実際に作って公開した(2019)

画像等の配列を扱うときの操作方法

TensorFlow + Kerasでフレンズ識別する - その2: 簡単なCNNを使った学習編

ディープラーニング 脱超初心者向け基礎知識

KerasでCNNを簡単に構築

美女を見分けられない機械はただの機械だ:Pythonによる機械学習用データセット生成

画像認識で坂道グループの判別AIの作成

画像認識で「綾鷹を選ばせる」AIを作る

MNISTでハイパーパラメータをいじってloss/accuracyグラフを見てみる

CNNをKerasで

最良のモデルを保存する(ModelCheckpointの使い方)

ディープラーニングを使用して「あなたにそっくりな女優判別プログラム」を作ったおはなし

KerasでDNN実装

KERASで学習済みのモデルをロードして画像1枚を判別

- 投稿日:2019-11-12T18:56:30+09:00

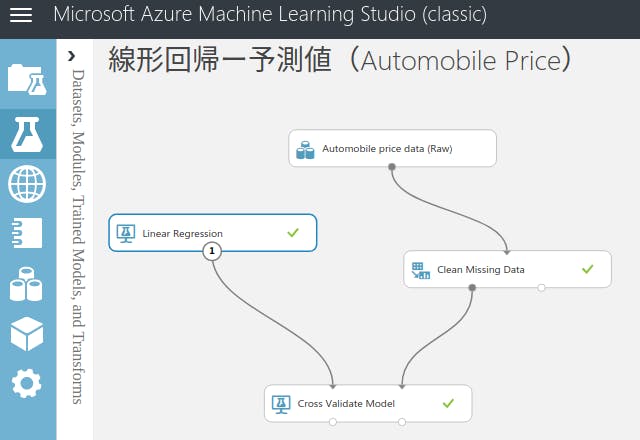

「Azure ML Studioで機械学習」の要点

「Azure ML Studioで機械学習」の要点

この本 →クラウドではじめる機械学習 改訂版

が簡素だけども難しすぎずに小綺麗にまとまっているので要点をまとめておく。

回帰による数値予測(サンプル:新車販売価格予測)

例:リテールでの販売予測(前年の販売数、曜日、天気、広告打った・打たない、などの相関項目をもとに解析し未来の販売数を予測。

線形回帰 (linear regression)

y : 予測日の販売数

x1~xm : 馬力、燃料タイプ、燃費、ホイールベース、ブランド価値、などの変数

w1~wm : 偏回帰係数(重みのこと. feature weight)

c : 定数項(Bias)

※ 変数が多すぎると過学習になる精度評価

・MAE(Mean Absolute Error: 平均絶対誤差)・・・0に近いほどいい

予測値と正解値の差を平均したもの。

・RMSE(Root Mean Squared Error: 二乗平均平方根誤差):

・法定係数(Coerfficient of Determination)

予測値と正解値の相関係数の二乗。1に近くなるほどいいデータ分割

・ホールドアウト法

学習用データを学習用と評価用にランダムに分割

・交差検証(cross validation)

学習用データをk個分に分割。そしてk回評価精度向上

・正規化(regularization)

変数が多すぎて重みパラメーターが大きくなりすぎ過学習するのをふせぐために重みパラメーターに比例するペナルティ値を加算する。

【数式】

予測値と正解値の誤差の二乗の和、に重みパラメーターの二乗の和をパラメーターとして加える。

ベイズ線形回帰 (bayesian linear regression)

計算式は線形回帰と同じ。ただ重みパラメーターが一定ではなく確率分布であるとするモデル。

最尤推定(MLE: Maximum Likelihood Estimation.誤差が0になるように重みパラメーターを定める方法)だけだと学習用データの数を考慮しない場合不正確になるところを、事象の起こった回数を考慮してくれる。(事前分布と事後分布)

クラス分類(サンプル:乳癌データから陽性陰性のクラス分類)

例:銀行での与信審査を職業、年収、預金額、延滞遅延などの相関項目を解析し支払い能力を予測。

ロジスティック回帰

x1~xm : 年齢、腫瘍の大きさ、腫瘍の悪性度、閉経したしない、などの変数

w1~wm : 偏回帰係数(重みのこと. feature weight)

c : 定数項(Bias)

P : 確率

確率の閾値をたとえば0.5にすることによって陽性陰性の推定をする1対多分類器(one-vs.-rest classifier)

A~Eまでクラスを作ったとしたら、それぞれに対する判別式(上記数式)を用意し最も高い確率を示したクラスに該当データを割り当てる。

1対1分類器(one-vs.-one classifier)

A~Eまでクラスを作ったとしたら、A-B,A-C,A-D...とすべての1対1の組み合わせを試す。組み合わせ数

k×(k-1)÷2回。A~Eだったら10回。その10回のうち多数決で多かったクラスに該当データを割り当て。精度評価

・正解率(Accuracy)・・・100%に近いほどいい

陽が9割あった場合、アホみたくぜんぶ正解にしてしまっても正解率90%になってしまう。・真陽性率(TPR: True Positive Rate)・・・100%に近いほどいい

陽データだけを対象にどのくらい合っていたか・偽陽性率(FPR: False Positive Rate)・・・0%に近いほどいい

陰データだけを対象にどのくらい誤って陽としてしまったか・AUC(Area Under the Curve)・・・1.0に近いほどいい

偽陽性率と真陽性率とはトレードオフになる。そこで偽陽性率と真陽性率をROC曲線のグラフにしその曲線の下側の面積がAUC。・適合率(Precision)・・・100%に近いほどいい

推測が陽としたデータを対象にどのくらい正解データも陽であるか・再現率(Recall)・・・100%に近いほどいい

正解データの陽を対象にどのくらい推測データが正しくよう陽と判定できたか。・F値(F1 score)・・・1.0に近いほどいい

再現率と適合率もトレードオフ。これを総合的に判断する指標

精度向上

ロジスティック回帰以外の手法を試す。サポートベクトルマシン(SVM)やDecision Forest、Boosted Decision Treeなど

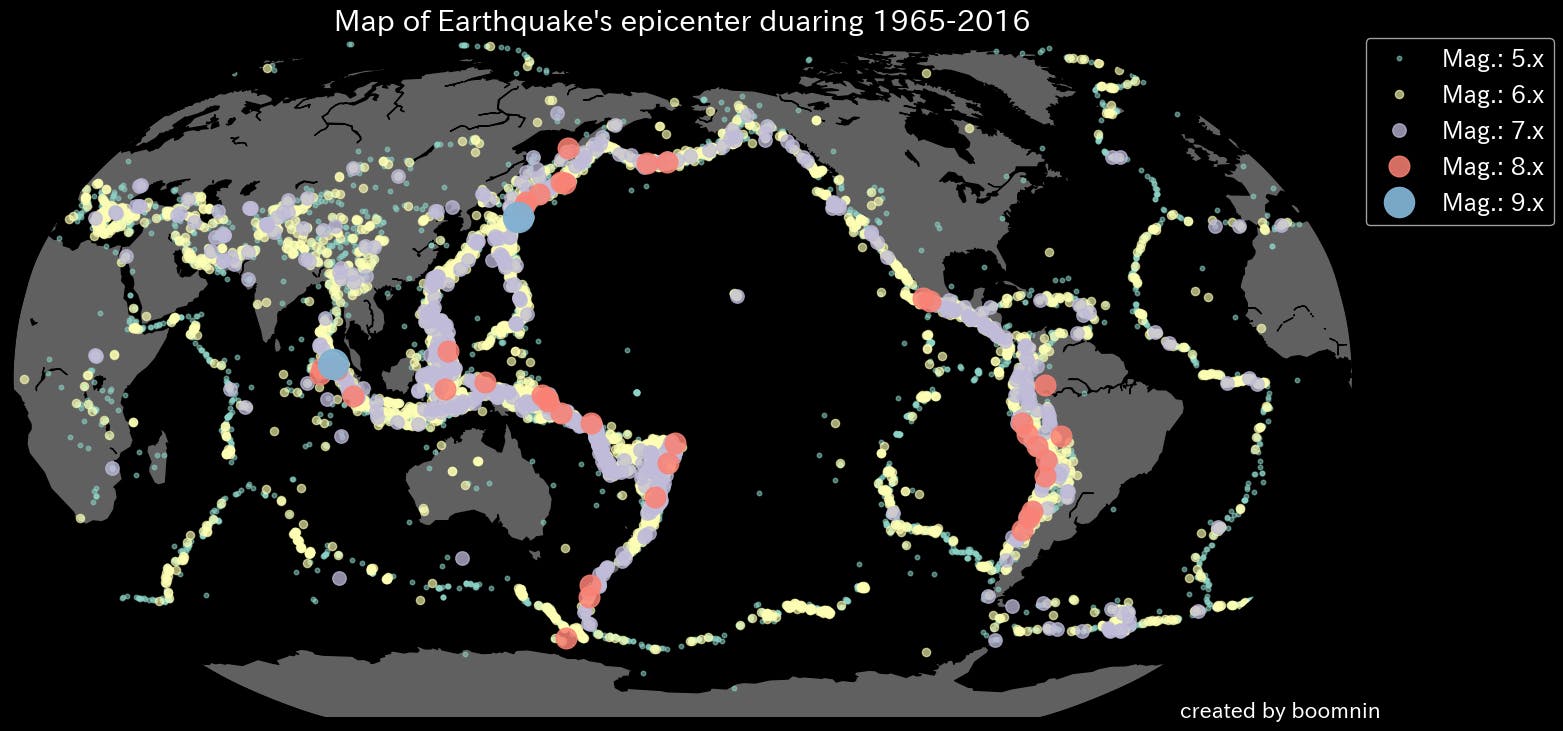

クラスタリング(サンプル:アヤメの分類)

例:旅行代理店の顧客の志向を、近場志向、海外志向、温泉志向などのグループに分類しそれぞれの志向にもとづいた販促資料を配布。

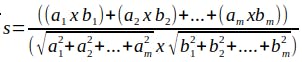

k-means法

任意のクラスタ数k個の中心点データを選び、ユークリッド距離またはコサイン類似度を用いて他のデータを各クラスタに分類する

ユークリッド距離

簡単。グラフ上の点aと点bの距離。

変数がm個の場合は【数式】

コサイン類似度

ベクトルの向きの近さ。同じ方向向いてれば+1, 垂直なら0, 逆向きなら-1

【数式】

k-means++法

k-means法を改良。これが主流。

クラスタの中心点をできるだけ離れるように選ぶ。また少数の集団はかけ離れたデータは無視する。精度評価

教師なし学習なので分析者が適当に見てみるしかない。

精度向上

・正規化

値のスケールが大きい変数xを平均値:0,標準偏差:1になるようにスケール変換する。z得点(z-score)とか呼ぶ。異常検知(サンプル:クレジットカード使用データから異常支払い検知)

例:河川の上流、中流、下流の各水位センサーから鉄砲水のような災害前兆を検知する。

One-Class SVM

密度推定アルゴリズム。データの正常域を円で表しその円に入らないデータを異常と検知。以下の数式で求められる値を最小化するように学習する。

【数式】

R: 円の半径

n: データ件数

ζ: データが円をはみ出した長さ

ν: 分析者があたえるペナルティの重み(小さくすればより多くの学習データを正常域に含めようとする。νが0だと学習用データのすべてを円内に収めてしまう)カーネルトリック

データの密集域が離れているときに、正常域を歪んだ曲線で囲ってくれる。

精度評価

・適合率(Precision)・・・大きいほど検知漏れが少ない

異常検知推測が「異常」としたデータを対象にどのくらい正解データも「異常」であるか・再現率(Recall)・・・大きいほど検知漏れが少ない

正解データの「異常」を対象にどのくらい推測データが正しく「異常」と判定できたか。・F値(F1 score)・・・1.0に近いほどいい

再現率と適合率もトレードオフ。これを総合的に判断する指標

精度向上

適合率と再現率はトレードオフ。異常事象の検知漏れを減らしたいか誤検知を減らしたいか。

νを大きくすると(0.5など)正常域は狭まる。逆に0.02などにするとだいぶ正常域に入ってしまう。ML Studioではηで設定する。カーネル関数を変えてみる

カーネルトリックで使われるカーネル関数。

・RBFカーネル(ML Studioのデフォルト)

・多項式カーネル

・シグモイドカーネル異常検知の手法を変えてみる

・主成分分析による異常検知(PCA-Based Anomaly Detection)

・Times Series Anomaly Detection(気温の変遷や株価推移など時系列データの場合)

レコメンデーション(サンプル:レストラン評価データよりユーザーにおすすめレストランを提示)

例:Amazonの「この商品を買った人は以下の商品も買ってます」みたいな

強調フィルタリング

自分が与えた評点(rating, preference)と他者が与えた評点を併用しておすすめ商品を推測。アイテムベースとユーザーベースがある。

アイテムベースレコメンド

ユーザーが高い評点を与えた商品と類似性の高い商品をレコメンド。

ユーザーベースレコメンド

ユーザーと類似度の高いユーザーを複数選び、それぞれが高い評点をつけた商品をレコメンド

MatchBox

強調フィルタリングでは初見ユーザーや新商品が蚊帳の外になる(コールドスタート問題(cold-start problem)。商品やユーザーの属性情報からレコメンドするようにしたマイクロソフト独自のアルゴリズム。さらに徐々に蓄積されていく評点も併用して使う。

【式】

κは属性の数従って学習用データは評点データ、ユーザー属性データ、商品属性データの3種類用意する。

精度評価

・NDCG(Normarized Discounted Cumulative Gain)・・・1.0に近いほどいい

デフォルト

・MAE(Mean Absolute Error: 平均絶対誤差)・・・0に近いほどいい

予測値と正解値の差を平均したもの。

・RMSE(Root Mean Squared Error: 二乗平均平方根誤差):精度向上

特徴ベクトルの長さ(κ)を調整する。MS Studioでは「Train Matchbox Recommender」の[Number of traits]

実用化

実戦モードに切り替え

1.Score Matchbox Recommenderの[Recommended item selection]を[From All Items]に変更する。→ 実戦モードに。

2. 入力ポートは利用者IDのみしか受け付けなくなるので、Manipulationから「Select Columns in Dataset」を追加してuserIDだけを出力するように設定。

3. RUN

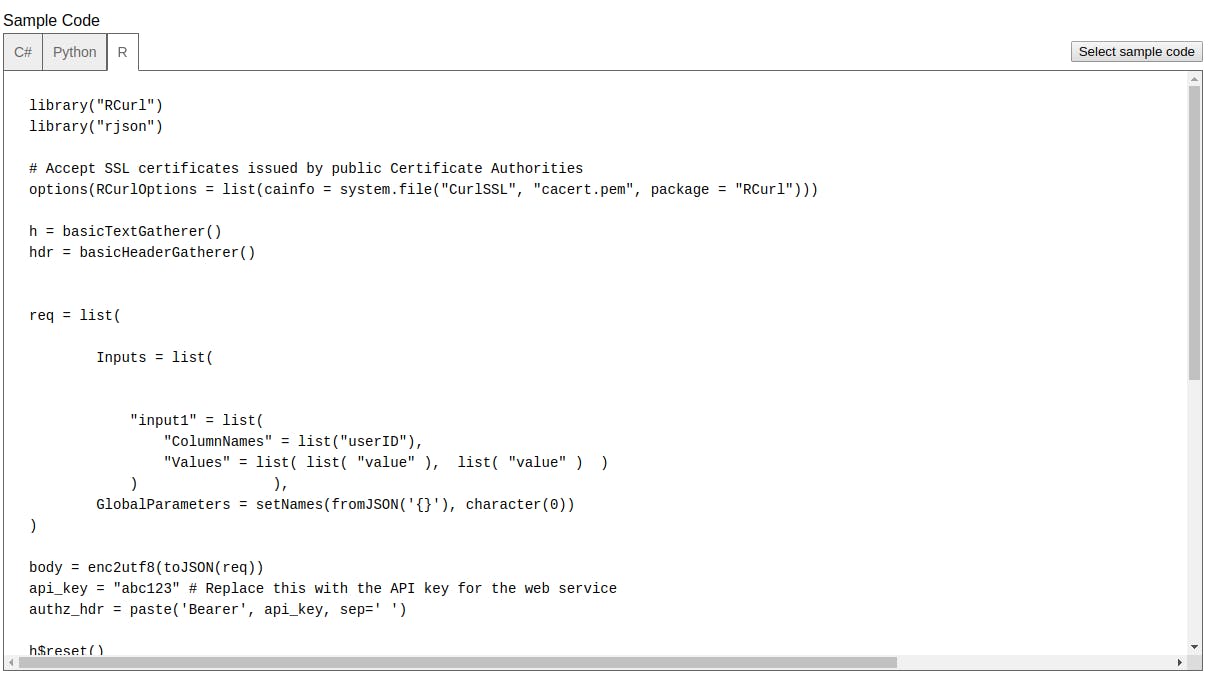

Webサービスの発行

実戦モードにて

1. [SET UP WEB SERVICE]から[Predictive Web Service]をクリック

2. [Web service input],[Web service output]モジュールが追加される

- [Select Columns in Dataset]を外して[Web service input]を[Score Matchbox Recommender]の入力ポートに。

6.コードの