- 投稿日:2020-12-01T23:49:03+09:00

PythonでQRコード読み取りをしてみる。 第一章・ただ読み取るだけ

はじめに

今やQRコードって色々なところで使われていると思います。

電子決済や、最近だと大阪府がコロナウィルスの追跡でもQRコードを利用しています。

こんなにQRコードが普及しているのだから、PythonでもQRコードを利用できないかと調べた所・・・

ありました。もう何でも出来るなPythonって経緯

経緯と書いて"いきさつ"と読む。かっこいいね。

実は身内の会社は未だに紙で出退勤登録をしているそうなので、以前不要になったPCとPythonを利用して出退勤登録をするシステムを作成しました。

ところが!最近のスマートフォンにはNFC装備がないものがあるらしく、新人さんのスマートフォンにはなんとNFCが搭載されていないとの連絡が来ました。

そこで社員全員に振り当てているID等のデータをQRにして出退勤登録できないかという話が出てきました。

と、言うわけで急遽プログラムをアップグレードすることに。

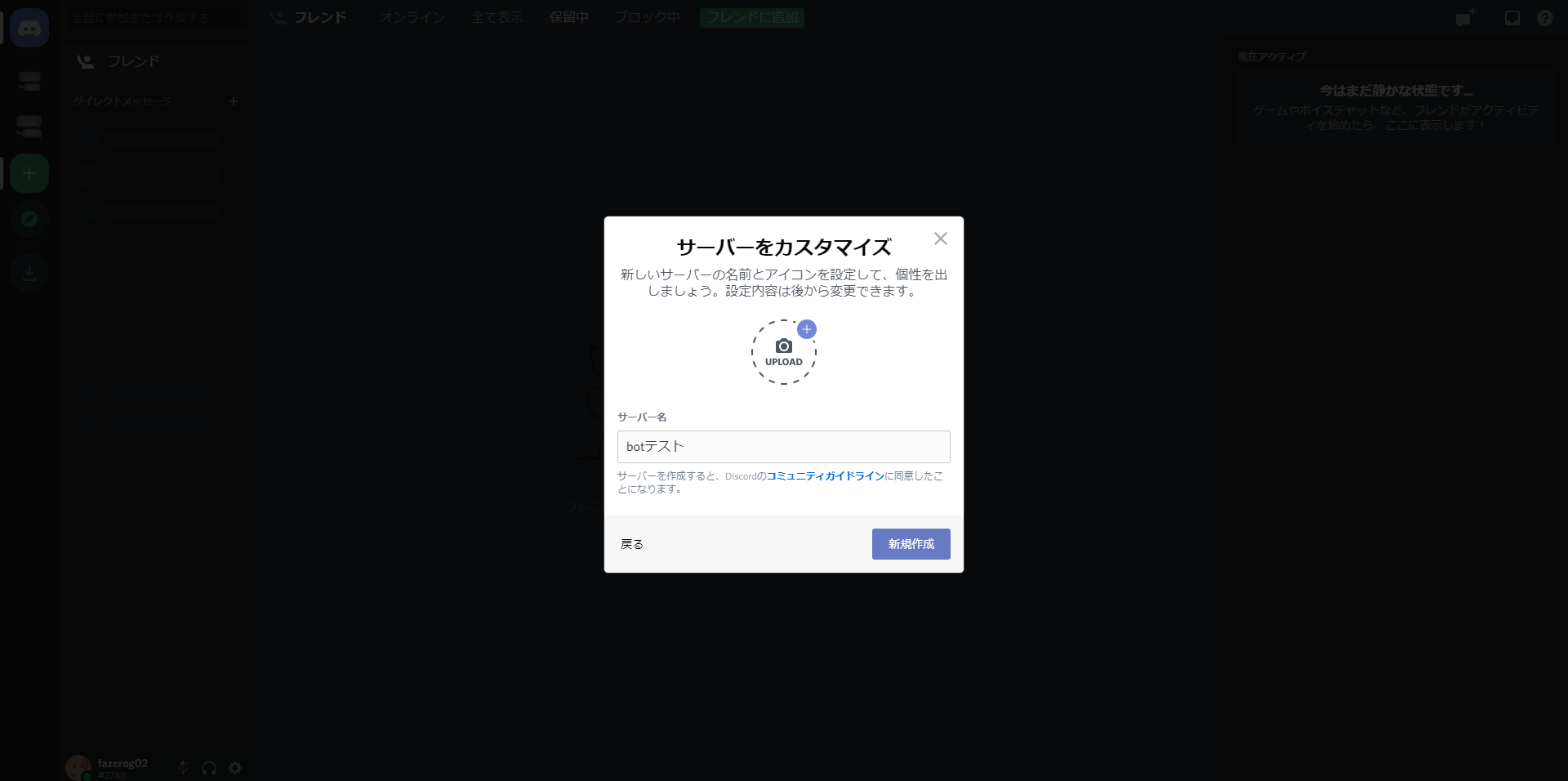

第一章である今回は、QRコードを読み取れるまでがゴールとしていきます。QRを作りたい

とはいっても既存のプログラムなんかとある程度の整合性を取るために、決められたデータのフォーマットのQRを生成するプログラムを作りたいよねってことで・・・

作りました。

私の十八番「Tkinter」を用いて簡単なQRコード作成ツールを用意しました。

ソースコードはこちら↓import sys import tkinter as tk import qrcode from PIL import Image def connect(): name = inputbox.get() empid = inbox.get() other = ibox.get() makeqr = qrcode.QRCode(box_size=3) makeqr.add_data(name+","+empid+","+other) makeqr.make() qr_makeimage = makeqr.make_image() qr_makeimage.save('qr'+name+empid+".png") root = tk.Tk() root.title('QRコード生成 NewCommer For Release Observer') root.geometry('600x400') maintext = tk.Label(text='名前・社員ID・備考を入力してください。') maintext.pack(anchor='center', expand=1) inputtext = tk.Label(text='名前') inputtext.pack(anchor='center', expand=1) inputbox = tk.Entry() inputbox.pack() inboxtext = tk.Label(text='社員ID') inboxtext.pack(anchor='center', expand=1) inbox = tk.Entry() inbox.pack() iboxtext = tk.Label(text='備考') iboxtext.pack(anchor='center', expand=1) ibox = tk.Entry() ibox.pack() enterbutton = tk.Button(text='生成', command=connect) enterbutton.pack(anchor='center',expand=1) root.mainloop()やっていることはとっても簡単。

テキストボックスの値を取得・カンマ区切りで連結しているだけ。

その連結した物をQR化して.pngファイルで出力しているだけ。

今回はセキュリティーデータを持ち運んでいるわけではないので、この程度でいいかなって感じです。

どうしてカンマ区切りにしたかというと、後々リストとして取得したいためです。読み取り

QRの読み取りは相当難しかったです。

はじめ自分でイチから組み立ててみたのですが、Pythonがクラッシュしてしまいシステムが停止します。

原因はわかりませんでしたが、こちらのサイト様を参考にしてコードを改良しました。from pyzbar.pyzbar import decode import cv2 from pygame import mixer systemonly = "" cap = cv2.VideoCapture(0) while cap.isOpened(): system,frame = cap.read() if system == True: dec = decode(frame) if dec: for qr in dec: x,y,w,h = qr.rect cv2.rectangle(frame,(x,y),(x+w,y+h),(0,255,0),2) commer = qr.data.decode('utf-8') if(systemonly != commer): mixer.init() qrlist = commer.split(",") mixer.music.load("sound/recognized.mp3") mixer.music.play(1) systemonly = commer print(qrlist[0]+"registrate completed.") cv2.imshow('Release Observer QRCode Recognize System',frame) if cv2.waitKey(1) & 0xFF == ord('q'): break cap.release()個人的な予想では、これと同時に動作させていたTkinterが悪さをしてそうでした。

今回は参考元サイト様を参考に「枠付け」を行いました。

参考元サイト様では認識枠の上に文字列を表示していましたが、日本語の文字化けが発生すること・単なる出退勤情報の登録だけということで、今回は行いませんでした。systemonly変数は、この読み取りシステムだとコンソール画面に認識している間無限にメッセージが表示されてしまうので、「1度読み取ったら変数に入れて表示を禁止する」コードにしました。

cv2.VideoCaptureは0番が内蔵カム・1番が確か外部カムだった気がします。

後は恐らく説明不要だと思います。

pygameは「読み取りが完了したら音を鳴らす」仕様にしたかったので採用しました。フリー音源を利用しています。

それで今回はまだ「読み取ること」が目標なので、データベースへの登録は行っていません。

その代わり、認識されたことがはっきりと分かるようにコンソール画面に「社員名 registrate completed.」を表示するようにしています。

本番環境でもこのシステムは残そうかと思っています。そして実際の動作がこちら↓

https://www.youtube.com/watch?v=PSU53UyISLs&feature=youtu.be

いいですねぇ。読み取れてます。次回予...告?

次回は実際にこのデータをデータベース登録ができるようにしていきたいと思います。

Pythonからのデータベースの操作は以前行ったことがあるので、非常にスムーズに事が運ぶ・・・と思いたい。

- 投稿日:2020-12-01T23:31:06+09:00

【Python】WebスクレイピングでYahoo!ニュースのコメントを取得する

はじめに

Yahoo!ニュースのコメントをたまに見るのですが、見ても5ページくらいですね。

返信コメントがあってもクリックしないと見れないので、見逃してしまうことがあります。この前、「【Python】Youtube Data Apiを使ってコメントを全取得する」を書いたのですが、

それならと今度はYahoo!ニュースのコメントも一括取得に挑戦しようと考えました。調査

Yahoo!ニュースのコメントの取得については、Youtube Data Apiのような提供しているAPIがありませんでした。

そこでネットで検索してみると下記の2記事を見つけました。どうやらWebスクレイピングするしかコメント取得の方法はないようです。

環境

今回は誰でも手軽にコメント取得が出来ればいいなと思って、Googleアカウントさえあれば直ぐに使える「Google Colaboratory」を使ってやりたかったので、プログラム言語としてはPythonにしたかった。

Webスクレイピング方法

PhantomJSブラウザの開発が中断しているため、下記を参考にSeleniumにてGoogle Chromeをヘッドレスモードを使用します。

静岡のGoToEat公式サイトをスクレイピング、伊豆のキャンペーン対象店をリスト化するPythonのスクレイピングライブラリに「Beautifulsoup4」がありますが、これだとJavaScriptの実行ができません。

返信のコメントを取得するには返信ボタンをクリックしてコメントデータを取得することになるので、JavaScriptの実行ができる「Selenium」を使用します。環境準備

Google Colaboratory にて、Selenium と ChromeDriver をインストールします。

下記を実行すれば動かせます。ただし、90分と12時間ルールで初期化されるので、その際にはインストールし直します。!apt-get update !apt install chromium-chromedriver !cp /usr/lib/chromium-browser/chromedriver /usr/bin !pip install seleniumGoogle Colaboratoryでは以下の条件を満たす場合、実行中のプログラムがあってもインスタンスの状態がすべてリセットされていまいます。

* 【12時間ルール】新しいインスタンスを起動してから12時間経過

* 【90分ルール】ノートブックのセッションが切れてから90分経過【簡単】GoogleColabの制限とは?90分と12時間ルール

Yahoo!ニュースのコメント仕様

Yahoo!ニュースは1ページに10件のコメントが表示されます。1ページ目に認証されたユーザーのコメントがあった場合はその分だけ多くなります。

「返信」ボタンの横に0以外の数値があれば、「返信」ボタンをクリックするとコメントが10件取得されて表示されます。10件以上あれば「もっと見る」のリンクが付き、それをクリックすれば次のコメントが10件単位で取得され表示されます。認証されたユーザーがコメントした場合、「返信」ボタンではなく「参考になった」ボタンが表示されます。この場合には返信はできません。

掲載期間

Yahoo!ニュースに掲載されている記事の掲載期間は、情報提供元により異なります。掲載期間を過ぎると、記事は削除されて読めなくなります。

トピックス一覧では、ニュース編集部がピックアップした話題を確認できますが、掲載開始から1週間以上経過したトピックスは読めません。また、掲載から1週間以内であっても、情報提供元により記事詳細を表示できない場合もあります。

記事の掲載期間 - Yahoo! JAPANヘルプセンター記事の掲載期間が終了した場合、コメントも削除されます。

仕様

タブ区切りでコメントの改行は半角空白に置換しています。

親連番は4桁、子の連番は3桁にしているので桁数を超えるコメントを取得したい場合は表示する桁数を変更増やすといいでしょう。000X (コメント) (グッド数/参考になった数) (バッド数) (ユーザー名) (日時) (返信数) 000X-00X (子コメント) (グッド数) (バッド数) (ユーザー名) (日時)使用方法

Google Colaboratoryを開いて上記サイトの「getYahooNewsComments.py」をコピペで貼り付け、指定URLを書き換えて実行します。

環境準備のところに記載しましたが、使用前にSelenium と ChromeDriver をインストールしてください。指定URL

「漫画家の水島新司さんが引退表明 野球漫画「ドカベン」など」の場合、アドレスバーのURLを指定します。

URL = "https://news.yahoo.co.jp/articles/c3fe0c9976b8a84b89ffa07bbd27890f944369fc/comments?order=recommended"ページ番号の「&page=2」の部分は、プログラムで付け加えているので外してセットしてください。

ページ範囲

プログラム上では開始(start)1ページ〜終了(end)2ページとしています。当然、終了ページを増やせば取得できます。

返信ボタンやもっと見るリンクをクリックする際に2秒待機していますので、ページ数を増やせば多少は時間がかかります。start = 1 end = 2プログラム

getYahooNewsComments.pyimport time from selenium import webdriver from selenium.webdriver.chrome.options import Options # ブラウザをバックグラウンド実行 options = webdriver.ChromeOptions() options.add_argument('--headless') options.add_argument('--no-sandbox') options.add_argument('--disable-dev-shm-usage') # ブラウザ起動 driver = webdriver.Chrome('chromedriver',options=options) URL = 'URLを入力' # 対象要素のテキスト取得 def getItem(element, name, name2): result = "" elem = element.find_elements_by_class_name(name) if len(elem) > 0: if name2 == "": result = elem[0].text.strip() else: result = elem[0].find_element_by_class_name(name2).text.strip() return result; # 認証者コメント出力 def print_authorComment(no): comment_boxes = driver.find_elements_by_css_selector('li[id^="authorcomment-"]') for comment_box in comment_boxes: #コメント取得 elem_comment = comment_box.find_element_by_class_name("comment") comment = elem_comment.text.strip().rstrip('...もっと見る') comment += comment_box.find_element_by_class_name("hideAthrCmtText").get_attribute("textContent") #ユーザー名取得 name = getItem(comment_box, "rapidnofollow", "") #日付取得 date = getItem(comment_box, "date", "") #参考になった数取得 refcnt = comment_box.find_elements_by_css_selector('li.reference a em')[0].text no += 1 print('{:0=4}\t{}\t{}\t{}\t{}\t{}\t{}'.format(no,comment.replace('\n', ' '), refcnt, "0", name, date, "0")) return no # 一般者コメント出力 def print_generalComment(no): comment_boxes = driver.find_elements_by_css_selector('li[id^="comment-"]') for comment_box in comment_boxes: #コメント取得 comment = getItem(comment_box, "cmtBody", "") #ユーザー名取得 name = getItem(comment_box, "rapidnofollow", "") #日付取得 date = getItem(comment_box, "date", "") #good数取得 agree = getItem(comment_box, "good", "userNum") #bad数取得 disagree = getItem(comment_box, "bad", "userNum") #返信数 reply = int(getItem(comment_box, "reply", "num") or "0") no += 1 print('{:0=4}\t{}\t{}\t{}\t{}\t{}\t{}'.format(no, comment.replace('\n', ' '), agree, disagree, name, date, reply)) if reply == 0: continue #返信出力 print_reply(comment_box, reply, no) return no # 返信コメント出力 def print_reply(element, reply, no): # 「返信」 リンクを click rep_links = element.find_elements_by_css_selector('a.btnView.expandBtn') for rep_link in rep_links: rep_link.click() time.sleep(2) # 「もっと見る」 リンクを click response_boxes = element.find_elements_by_class_name("response") for i in range(int(reply/10)): if len(response_boxes) > 0 and (reply % 10) > 0: rep_links = response_boxes[0].find_elements_by_css_selector('a.moreReplyCommentList') for rep_link in rep_links: rep_link.click() time.sleep(2) # 返信コメント 取り出し replys = response_boxes[0].find_elements_by_css_selector('li[id^="reply-"]') cno = 1 for reply in replys: cmtBodies = reply.find_elements_by_css_selector('div.action article p span.cmtBody') if len(cmtBodies) == 0: continue #コメント取得 comment = cmtBodies[0].text.strip() #ユーザー名取得 name = getItem(reply, "rapidnofollow", "") #日付取得 date = getItem(reply, "date", "") #good数取得 agree = getItem(reply, "good", "userNum") #bad数取得 disagree = getItem(reply, "bad", "userNum") print('{:0=4}-{:0=3}\t{}\t{}\t{}\t{}\t{}'.format(no, cno, comment.replace('\n', ' '), agree, disagree, name, date)) cno += 1 # コメント取り出し start = 1 end = 2 no = 0 for page in range(start, end + 1): driver.get(URL + "&page={}".format(page)) iframe = driver.find_element_by_class_name("news-comment-plguin-iframe") driver.switch_to.frame(iframe) #認証者コメント if page == 1: no = print_authorComment(no) #一般者コメント no = print_generalComment(no)プログラムの説明

Pythonは、たまに記述しないのでプログラム的にはベタに書いています。その方が他の言語に移植しやすいかな。

返信コメントは「もっと見る」がなくなるまでクリックしてから、一気にコメントを取得しています。

改行を半角スペースに置換してるので読みやすさは特に考慮してません、Excelに貼り付けて折り返して見ればいい。「...もっと見る」の後のテキストがあるのに属性が「display:none」になっていることで取得できなくて困っていたのですが、下記サイトの方法で解決できました。ありがとうございます。

Seleniumでタグに囲まれた文字列を.textで取得すると空文字が返ってくる#コメント取得 elem_comment = comment_box.find_element_by_class_name("comment") comment = elem_comment.text.strip().rstrip('...もっと見る') comment += comment_box.find_element_by_class_name("hideAthrCmtText").get_attribute("textContent")実行結果

「漫画家の水島新司さんが引退表明 野球漫画「ドカベン」など」のYahoo!ニュースのコメントを取得すると、下記のようになります。

コメント取得例0001 10年近く前、・・・ます。 4792 0 菊地高弘 11時間前 0 0002 いつかは・・・言えるでしょう。 2938 0 河村鳴紘 11時間前 0 0003 10年ほど前、・・・あります。 1282 0 阿佐智 10時間前 0 0004 ユニークな・・・お疲れ様でした。 5978 649 dck***** 12時間前 61 0004-001 YahooTOP記事・・・お過ごしください。 101 0 p******* 12時間前 0004-002 水島先生・・・思います。 63 0 gtj***** 11時間前最後に

Advent Calendarが始まりました。今年も「Visual Basic Advent Calendar 2020」を記事を募集しています。

これでPythonではなく Visual BasicやExcelでやってみるなどのネタができそうです。

- 投稿日:2020-12-01T23:17:42+09:00

画像処理100本ノック!!(031 - 040)まだまだここから

1. はじめに

画像の前処理の技術力向上のためにこちらを実践 画像処理100本ノック!!

とっかかりやすいようにColaboratoryでやります。

目標は2週間で完了できるようにやっていきます。丁寧に解説します。質問バシバシください!

001 - 010 は右のリンク 画像処理100本ノック!!(001 - 010)丁寧にじっくりと

011 - 020 は右のリンク 画像処理100本ノック!!(011 - 020)序盤戦

021 - 030 は右のリンク 画像処理100本ノック!!(021 - 030)一息入れたい・・・2. 前準備

ライブラリ等々を以下のように導入。

# ライブラリをインポート from google.colab import drive import numpy as np import matplotlib.pyplot as plt import cv2 from google.colab.patches import cv2_imshow # 画像の読み込み img = cv2.imread('画像のパス/imori.jpg') img_noise = cv2.imread('画像のパス/imori_noise.jpg') img_dark = cv2.imread('画像のパス/imori_dark.jpg') img_gamma = cv2.imread('画像のパス/imori_gamma.jpg') # グレースケール画像 gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY) gray_noise = cv2.cvtColor(img_noise, cv2.COLOR_BGR2GRAY) gray_dark = cv2.cvtColor(img_dark, cv2.COLOR_BGR2GRAY) # 画像保存用 OUT_DIR = '出力先のパス/OUTPUT/'3.解説

Q.31. アフィン変換(スキュー)

1)アフィン変換を用いて、出力(1)のようなX-sharing(dx = 30)画像を作成せよ。

(2)アフィン変換を用いて、出力2のようなY-sharing(dy = 30)画像を作成せよ。

(3)アフィン変換を用いて、出力3のような幾何変換した(dx = 30, dy = 30)画像を作成せよ。

このような画像はスキュー画像と呼ばれ、画像を斜め方向に伸ばした画像である。

出力(1)の場合、x方向にdxだけ引き伸ばした画像はX-sharingと呼ばれる。

出力(2)の場合、y方向にdyだけ引き伸ばした画像はY-sharingと呼ばれる。

それぞれ次式のアフィン変換で実現できる。 ただし、元画像のサイズがh x wとする。A31def affine_skew(img, dx, dy): """ params ------------------------------ param1: numpy.ndarray形式のimage param2: x軸方向のスキュー param2: y軸方向のスキュー returns ------------------------------ numpy.ndarray形式のimage """ # 画像の高さ、幅、色を取得 H, W = img.shape[:2] # xy座標をnp.float32型(3点分のxy座標) src = np.array([[0.0, 0.0],[0.0, 1.0],[1.0, 0.0]], np.float32) dest = src.copy() # 変換後の3点の座標 dest[:,0] += (dx / W * (src[:,1])).astype(np.float32) dest[:,1] += (dy / H * (src[:,0])).astype(np.float32) """ アフィン変換の変換行列を生成: cv2.getAffineTransform(src, dest) src: 変換前の3点の座標 dest: 変換後の3点の座標をNumPy配列ndarrayで指定 """ affine = cv2.getAffineTransform(src, dest) """ アフィン変換 cv2.warpAffine(src, M, dsize[, dst[, flags[, borderMode[, borderValue]]]]) 第一引数に元画像(NumPy配列ndarray)、 第二引数に2 x 3の変換行列(NumPy配列ndarray)、 第三引数に出力画像のサイズ(タプル)を指定する。 """ return cv2.warpAffine(img, affine, (W+dx, H+dy)) # X-sharing(dx = 30)画像 out1 = affine_skew(img, 30, 0) # Y-sharing(dy = 30)画像 out2 = affine_skew(img, 0, 30) # 幾何変換した(dx = 30, dy = 30)画像 out3 = affine_skew(img, 30, 30) # 結果を保存する cv2.imwrite(OUT_DIR + 'ans31_1.jpg', out1) cv2.imwrite(OUT_DIR + 'ans31_2.jpg', out2) cv2.imwrite(OUT_DIR + 'ans31_3.jpg', out3) # 画像を表示 cv2_imshow(out1) cv2_imshow(out2) cv2_imshow(out3) cv2.waitKey(0) cv2.destroyAllWindows()参考: 完全に理解するアフィン変換

Q.32. フーリエ変換

二次元離散フーリエ変換(DFT)を実装し、imori.jpgをグレースケール化したものの周波数のパワースペクトルを表示せよ。 また、逆二次元離散フーリエ変換(IDFT)で画像を復元せよ。

二次元離散フーリエ変換(DFT: Discrete Fourier Transformation)とはフーリエ変換の画像に対する処理方法である。

通常のフーリエ変換はアナログ信号や音声などの連続値かつ一次元を対象に周波数成分を求める計算処理である。

一方、ディジタル画像は[0,255]の離散値をとり、かつ画像はHxWの二次元表示であるので、二次元離散フーリエ変換が行われる。

二次元離散フーリエ変換(DFT)は次式で計算される。

K = [0, W-1], l = [0, H-1], 入力画像を I として

ここでは画像をグレースケール化してから二次元離散フーリエ変換を行え。

パワースペクトルとは Gは複素数で表されるので、Gの絶対値を求めることである。 今回のみ画像表示の時はパワースペクトルは[0,255]にスケーリングせよ。

逆二次元離散フーリエ変換(IDFT: Inverse DFT)とは周波数成分Gから元の画像を復元する手法であり、次式で定義される。

x = [0, W-1], y = [0, H-1] として

上が定義式ですがexp(j)は複素数の値をとってしまうので、実際にコードにするときはぜ下式のように絶対値を使います

シンプルに全部for文で回すと128^4の計算になるので、時間がかかってしまいます。numpyをうまく活用すれば計算コストを減らすことができます。(解答は128^2まで減らしました。)

A32# 2次元離散フーリエ変換 (DFT)のハイパーパラメーター K, L = 128, 128 channel = 3 def dft(img): """ 2次元離散フーリエ変換 (DFT) params -------------------------------------- param: numpy.ndarray形式のimage returns ------------------------------ 周波数成分G """ # 画像の高さ、幅を取得 H, W = img.shape[:2] # DFT係数(np.complex: 複素数を扱うための型) G = np.zeros((L, K, channel), dtype=np.complex) # 元のイメージと一致(NumPy配列ndarrayをタイル状に繰り返し並べるnp.tile) x = np.tile(np.arange(W), (H, 1)) # >>> [0 1 2 ・・・・ 125 126 127] y = np.arange(H).repeat(W).reshape(H, -1) # >>> [0 0 0 0]・・・・[127 127 127・・・] # DFTの計算(周波数成分G) for c in range(channel): for l in range(L): for k in range(K): G[l, k, c] = np.sum(img[..., c] * np.exp(-2j * np.pi * (x * k / K + y * l / L))) / np.sqrt(K * L) return G # IDFT(逆二次元離散フーリエ変換) def idft(G): """ 逆二次元離散フーリエ変換 (IDFT) params -------------------------------------- param: 周波数成分G returns ------------------------------ numpy.ndarray形式のimage """ # 画像の高さ、幅を取得 H, W = G.shape[:2] # DFT係数(np.complex: 複素数を扱うための型) out = np.zeros((H, W, channel), dtype=np.float32) # 元のイメージと一致(NumPy配列ndarrayをタイル状に繰り返し並べるnp.tile) x = np.tile(np.arange(W), (H, 1)) y = np.arange(H).repeat(W).reshape(H, -1) # IDFT(逆二次元離散フーリエ変換) for c in range(channel): for l in range(H): for k in range(W): out[l, k, c] = np.abs(np.sum(G[..., c] * np.exp(2j * np.pi * (x * k / W + y * l / H)))) / np.sqrt(W * H) # clipping(NumPy配列ndarrayを任意の最小値・最大値に収めるclip) # 0 ~ 255の範囲 out = np.clip(out, 0, 255) out = out.astype(np.uint8) return out # 2次元離散フーリエ変換 G = dft(img) # 周波数のパワースペクトル ps = (np.abs(G) / np.abs(G).max() * 255).astype(np.uint8) cv2.imwrite("out_ps.jpg", ps) # 逆二次元離散フーリエ変換 out = idft(G) # 保存 cv2_imshow(out) cv2.waitKey(0) cv2.imwrite("img32.jpg", out)参考: 【Python/OpenCV】高速フーリエ変換でパワースペクトルの算出

参考: フーリエ変換Q.33. フーリエ変換 ローパスフィルタ

imori.jpgをグレースケール化したものをDFTし、ローパスフィルタを通してIDFTで画像を復元せよ。

DFTによって得られた周波数成分は左上、右上、左下、右下に近いほど低周波数の成分を含んでいることになり、中心に近いほど高周波成分を示す。

画像における高周波成分とは色が変わっている部分(ノイズや輪郭など)を示し、低周波成分とは色があまり変わっていない部分(夕日のグラデーションなど)を表す。 ここでは、高周波成分をカットし、低周波成分のみを通すローパスフィルタを実装せよ。ここでは低周波数の中心から高周波までの距離をrとすると0.5rまでの成分を通すとする。A33# 2次元離散フーリエ変換 (DFT)のハイパーパラメーター K, L = 128, 128 channel = 3 def dft(img): """ 2次元離散フーリエ変換 (DFT) params -------------------------------------- param: numpy.ndarray形式のimage returns ------------------------------ 周波数成分G """ # 画像の高さ、幅を取得 H, W = img.shape[:2] # DFT係数(np.complex: 複素数を扱うための型) G = np.zeros((L, K, channel), dtype=np.complex) # 元のイメージと一致(NumPy配列ndarrayをタイル状に繰り返し並べるnp.tile) x = np.tile(np.arange(W), (H, 1)) # >>> [0 1 2 ・・・・ 125 126 127] y = np.arange(H).repeat(W).reshape(H, -1) # >>> [0 0 0 0]・・・・[127 127 127・・・] # DFTの計算(周波数成分G) for c in range(channel): for l in range(L): for k in range(K): G[l, k, c] = np.sum(img[..., c] * np.exp(-2j * np.pi * (x * k / K + y * l / L))) / np.sqrt(K * L) return G # IDFT(逆二次元離散フーリエ変換) def idft(G): """ 逆二次元離散フーリエ変換 (IDFT) params -------------------------------------- param: 周波数成分G returns ------------------------------ numpy.ndarray形式のimage """ # 画像の高さ、幅を取得 H, W = G.shape[:2] # DFT係数(np.complex: 複素数を扱うための型) out = np.zeros((H, W, channel), dtype=np.float32) # 元のイメージと一致(NumPy配列ndarrayをタイル状に繰り返し並べるnp.tile) x = np.tile(np.arange(W), (H, 1)) y = np.arange(H).repeat(W).reshape(H, -1) # IDFT(逆二次元離散フーリエ変換) for c in range(channel): for l in range(H): for k in range(W): out[l, k, c] = np.abs(np.sum(G[..., c] * np.exp(2j * np.pi * (x * k / W + y * l / H)))) / np.sqrt(W * H) # clipping(NumPy配列ndarrayを任意の最小値・最大値に収めるclip) # 0 ~ 255の範囲 out = np.clip(out, 0, 255) out = out.astype(np.uint8) return out def lpf(G, ratio=0.5): """ ローパスフィルタ: 信号の低周波数成分のみを通過 params -------------------------------------- param1: 周波数成分G param2: 割合 returns ------------------------------ 周波数成分G """ # 画像の高さ、幅を取得 H, W = G.shape[:2] # 元の配列と同じ形状の配列を生成 _G = np.zeros_like(G) # 第1象限と第3象限、第1象限と第4象限を入れ替え _G[:H//2, :W//2] = G[H//2:, W//2:] _G[:H//2, W//2:] = G[H//2:, :W//2] _G[H//2:, :W//2] = G[:H//2, W//2:] _G[H//2:, W//2:] = G[:H//2, :W//2] # fsrc = np.fft.fftshift(src) # 元のイメージと一致(NumPy配列ndarrayをタイル状に繰り返し並べるnp.tile) x = np.tile(np.arange(W), (H, 1)) y = np.arange(H).repeat(W).reshape(H, -1) # フィルターの作成 _x = x - W // 2 _y = y - H // 2 r = np.sqrt(_x ** 2 + _y ** 2) # マスクの作成 mask = np.ones((H, W), dtype=np.float32) mask[r > (W // 2 * ratio)] = 0 mask = np.repeat(mask, channel).reshape(H, W, channel) # フィルタリング _G *= mask # 入れ替え G[:H//2, :W//2] = _G[H//2:, W//2:] G[:H//2, W//2:] = _G[H//2:, :W//2] G[H//2:, :W//2] = _G[:H//2, W//2:] G[H//2:, W//2:] = _G[:H//2, :W//2] return G H, W, C = img.shape # 2次元離散フーリエ変換 G = dft(img) # ローパスフィルタ G = lpf(G) # 逆二次元離散フーリエ変換 out = idft(G) # 保存 cv2_imshow(out) cv2.waitKey(0) cv2.imwrite("img33.jpg", out)参考: 【Python/OpenCV】フーリエ変換+ローパスフィルタでノイズ除去

Q.34. フーリエ変換 ハイパスフィルタ

imori.jpgをグレースケール化したものをDFTし、ハイパスフィルタを通してIDFTで画像を復元せよ。

ここでは、低周波成分をカットし、高周波成分のみを通すハイパスフィルタを実装せよ。

ここでは低周波数の中心から高周波までの距離をrとすると0.1rからの成分を通すとする。A34# 2次元離散フーリエ変換 (DFT)のハイパーパラメーター K, L = 128, 128 channel = 3 def dft(img): """ 2次元離散フーリエ変換 (DFT) params -------------------------------------- param: numpy.ndarray形式のimage returns ------------------------------ 周波数成分G """ # 画像の高さ、幅を取得 H, W = img.shape[:2] # DFT係数(np.complex: 複素数を扱うための型) G = np.zeros((L, K, channel), dtype=np.complex) # 元のイメージと一致(NumPy配列ndarrayをタイル状に繰り返し並べるnp.tile) x = np.tile(np.arange(W), (H, 1)) # >>> [0 1 2 ・・・・ 125 126 127] y = np.arange(H).repeat(W).reshape(H, -1) # >>> [0 0 0 0]・・・・[127 127 127・・・] # DFTの計算(周波数成分G) for c in range(channel): for l in range(L): for k in range(K): G[l, k, c] = np.sum(img[..., c] * np.exp(-2j * np.pi * (x * k / K + y * l / L))) / np.sqrt(K * L) return G # IDFT(逆二次元離散フーリエ変換) def idft(G): """ 逆二次元離散フーリエ変換 (IDFT) params -------------------------------------- param: 周波数成分G returns ------------------------------ numpy.ndarray形式のimage """ # 画像の高さ、幅を取得 H, W = G.shape[:2] # DFT係数(np.complex: 複素数を扱うための型) out = np.zeros((H, W, channel), dtype=np.float32) # 元のイメージと一致(NumPy配列ndarrayをタイル状に繰り返し並べるnp.tile) x = np.tile(np.arange(W), (H, 1)) y = np.arange(H).repeat(W).reshape(H, -1) # IDFT(逆二次元離散フーリエ変換) for c in range(channel): for l in range(H): for k in range(W): out[l, k, c] = np.abs(np.sum(G[..., c] * np.exp(2j * np.pi * (x * k / W + y * l / H)))) / np.sqrt(W * H) # clipping(NumPy配列ndarrayを任意の最小値・最大値に収めるclip) # 0 ~ 255の範囲 out = np.clip(out, 0, 255) out = out.astype(np.uint8) return out def hpf(G, ratio=0.1): """ ハイパスフィルタは、信号の高周波数成分のみを通過させる。 params -------------------------------------- param: 周波数成分G returns ------------------------------ 周波数成分G """ H, W = G.shape[:2] # 第1象限と第3象限、第1象限と第4象限を入れ替え _G = np.zeros_like(G) _G[:H//2, :W//2] = G[H//2:, W//2:] _G[:H//2, W//2:] = G[H//2:, :W//2] _G[H//2:, :W//2] = G[:H//2, W//2:] _G[H//2:, W//2:] = G[:H//2, :W//2] # 中心からの距離 x = np.tile(np.arange(W), (H, 1)) y = np.arange(H).repeat(W).reshape(H, -1) # フィルター作成 _x = x - W // 2 _y = y - H // 2 r = np.sqrt(_x ** 2 + _y ** 2) # マスクの作成 mask = np.ones((H, W), dtype=np.float32) mask[r < (W // 2 * ratio)] = 0 mask = np.repeat(mask, channel).reshape(H, W, channel) # フィルタリング _G *= mask # 入れ替え G[:H//2, :W//2] = _G[H//2:, W//2:] G[:H//2, W//2:] = _G[H//2:, :W//2] G[H//2:, :W//2] = _G[:H//2, W//2:] G[H//2:, W//2:] = _G[:H//2, :W//2] return G # DFT G = dft(img) # HPF G = hpf(G) # IDFT out = idft(G) # 画像表示 cv2_imshow(out) cv2.waitKey(0) cv2.imwrite("img34.jpg", out)

OpenCVでやろうとしたがうまくいかず、実行もかなり遅い。要改善。Q.35. フーリエ変換 バンドパスフィルタ

imori.jpgをグレースケール化したものをDFTし、ハイパスフィルタを通してIDFTで画像を復元せよ。

ここでは、低周波成分と高周波成分の中間の周波数成分のみを通すハイパスフィルタを実装せよ。

ここでは低周波数の中心から高周波までの距離をrとすると0.1rから0.5rまでの成分を通すとする。A35# 2次元離散フーリエ変換 (DFT)のハイパーパラメーター K, L = 128, 128 channel = 3 def dft(img): """ 2次元離散フーリエ変換 (DFT) params -------------------------------------- param: numpy.ndarray形式のimage returns ------------------------------ 周波数成分G """ # 画像の高さ、幅を取得 H, W = img.shape[:2] # DFT係数(np.complex: 複素数を扱うための型) G = np.zeros((L, K, channel), dtype=np.complex) # 元のイメージと一致(NumPy配列ndarrayをタイル状に繰り返し並べるnp.tile) x = np.tile(np.arange(W), (H, 1)) # >>> [0 1 2 ・・・・ 125 126 127] y = np.arange(H).repeat(W).reshape(H, -1) # >>> [0 0 0 0]・・・・[127 127 127・・・] # DFTの計算(周波数成分G) for c in range(channel): for l in range(L): for k in range(K): G[l, k, c] = np.sum(img[..., c] * np.exp(-2j * np.pi * (x * k / K + y * l / L))) / np.sqrt(K * L) return G # IDFT(逆二次元離散フーリエ変換) def idft(G): """ 逆二次元離散フーリエ変換 (IDFT) params -------------------------------------- param: 周波数成分G returns ------------------------------ numpy.ndarray形式のimage """ # 画像の高さ、幅を取得 H, W = G.shape[:2] # DFT係数(np.complex: 複素数を扱うための型) out = np.zeros((H, W, channel), dtype=np.float32) # 元のイメージと一致(NumPy配列ndarrayをタイル状に繰り返し並べるnp.tile) x = np.tile(np.arange(W), (H, 1)) y = np.arange(H).repeat(W).reshape(H, -1) # IDFT(逆二次元離散フーリエ変換) for c in range(channel): for l in range(H): for k in range(W): out[l, k, c] = np.abs(np.sum(G[..., c] * np.exp(2j * np.pi * (x * k / W + y * l / H)))) / np.sqrt(W * H) # clipping(NumPy配列ndarrayを任意の最小値・最大値に収めるclip) # 0 ~ 255の範囲 out = np.clip(out, 0, 255) out = out.astype(np.uint8) return out def bpf(G, ratio1=0.1, ratio2=0.5): """ バンドパスフィルタ: ある帯域のみを通したいときに使います params -------------------------------------- param1: 周波数成分G param2: 成分範囲 param3: 成分範囲 returns ------------------------------ 周波数成分G """ H, W, _ = G.shape # 第1象限と第3象限、第1象限と第4象限を入れ替え _G = np.zeros_like(G) _G[:H//2, :W//2] = G[H//2:, W//2:] _G[:H//2, W//2:] = G[H//2:, :W//2] _G[H//2:, :W//2] = G[:H//2, W//2:] _G[H//2:, W//2:] = G[:H//2, :W//2] # 中心からの距離 x = np.tile(np.arange(W), (H, 1)) y = np.arange(H).repeat(W).reshape(H, -1) # フィルター作成 _x = x - W // 2 _y = y - H // 2 r = np.sqrt(_x ** 2 + _y ** 2) # マスクの作成 mask = np.ones((H, W), dtype=np.float32) # 範囲を指定 mask[(r < (W // 2 * ratio1)) | (r > (W // 2 * ratio2))] = 0 mask = np.repeat(mask, channel).reshape(H, W, channel) # フィルタリング _G *= mask # 入れ替え G[:H//2, :W//2] = _G[H//2:, W//2:] G[:H//2, W//2:] = _G[H//2:, :W//2] G[H//2:, :W//2] = _G[:H//2, W//2:] G[H//2:, W//2:] = _G[:H//2, :W//2] return G # DFT G = dft(img) # BPF G = bpf(G) # IDFT out = idft(G) # 画像表示 cv2_imshow(out) cv2.waitKey(0) cv2.imwrite("img35.jpg", out)

参考: 画像処理におけるフーリエ変換④〜pythonによるフィルタ設計〜Q.36. JPEG圧縮 (Step.1)離散コサイン変換

imori.jpgをグレースケール化し離散コサイン変換を行い、逆離散コサイン変換を行え。

離散コサイン変換(DCT: Discrete Cosine Transformation)とは、次式で定義される周波数変換の一つである。

逆離散コサイン変換(IDCT: Inverse Discrete Cosine Transformation)とは離散コサイン変換の逆(復号)であり、次式で定義される。 ここでいう K は復元時にどれだけ解像度を良くするかを決定するパラメータである。 K = Tの時は、DCT係数を全部使うのでIDCT後の解像度は最大になるが、Kが1や2などの時は復元に使う情報量(DCT係数)が減るので解像度が下がる。これを適度に設定することで、画像の容量を減らすことができる。

ここでは画像を8x8ずつの領域に分割して、各領域で以上のDCT, IDCTを繰り返すことで、jpeg符号に応用される。 今回も同様に8x8の領域に分割して、DCT, IDCTを行え。A36# DCT hyoer-parameter T = 8 K = 8 # 復元時にどれだけ解像度を良くするかを決定するパラメータ channel = 3 # DCT weight def w(x, y, u, v): """ 離散コサイン変換(DCT: Discrete Cosine Transformation) の係数 params ------------------------------- returns ------------------------------- 係数 """ cu = 1. cv = 1. if u == 0: cu /= np.sqrt(2) if v == 0: cv /= np.sqrt(2) theta = np.pi / (2 * T) return (( 2 * cu * cv / T) * np.cos((2*x+1)*u*theta) * np.cos((2*y+1)*v*theta)) # DCT def dct(img): """ 離散コサイン変換(DCT: Discrete Cosine Transformation) params ----------------------------- img: numpy.ndarray形式のimage returns ----------------------------- 離散コサイン変換(DCT: Discrete Cosine Transformation) """ # 画像の高さ、幅を取得 H, W, _ = img.shape # 0を要素とする配列を生成する F = np.zeros((H, W, channel), dtype=np.float32) # rgbそれぞれのチャネル for c in range(channel): # 縦方向にT(8)の間隔 for yi in range(0, H, T): # 横方向にT(8)の間隔 for xi in range(0, W, T): for v in range(T): for u in range(T): for y in range(T): for x in range(T): # 各画素に対して離散コサイン変換 F[v+yi, u+xi, c] += img[y+yi, x+xi, c] * w(x,y,u,v) return F # IDCT def idct(F): """ 逆離散コサイン変換 params ----------------------------- F: 離散コサイン変換 returns ----------------------------- 逆離散コサイン変換 """ # 画像の高さ、幅を取得 H, W, _ = F.shape # 0を要素とする配列を生成する out = np.zeros((H, W, channel), dtype=np.float32) for c in range(channel): for yi in range(0, H, T): for xi in range(0, W, T): for y in range(T): for x in range(T): for v in range(K): for u in range(K): out[y+yi, x+xi, c] += F[v+yi, u+xi, c] * w(x,y,u,v) # clipping(NumPy配列ndarrayを任意の最小値・最大値に収めるclip) out = np.clip(out, 0, 255) out = np.round(out).astype(np.uint8) return out # DCT F = dct(img) # IDCT out = idct(F) # 画像表示 cv2_imshow(out) cv2.waitKey(0) cv2.imwrite("img36.jpg", out)参考: 「離散コサイン変換」4-7【4章 三角関数、数学大百科事典】

こちらに関しては説明が難しい・・・

Q.37. PSNR

IDCTで用いるDCT係数を8でなく、4にすると画像の劣化が生じる。 入力画像とIDCT画像のPSNRを求めよ。また、IDCTによるビットレートを求めよ。

PSNR(Peak Signal to Noise Ratio)とは信号対雑音比と呼ばれ、画像がどれだけ劣化したかを示す。

PSNRが大きいほど、画像が劣化していないことを示し、次式で定義される。 v_maxは取りうる値の最大値で[0,255]の表示なら v_max=255 となる。

式中のMSEはMean Squared Error(平均二乗誤差)と呼ばれ、二つの画像の差分の二乗の平均値を示す。

ビットレートとは8x8でDCTを行い、IDCTでKxKの係数までを用いた時に次式で定義される。

A37# DCT hyoer-parameter T = 8 K = 4 channel = 3 # DCT weight def w(x, y, u, v): """ 離散コサイン変換(DCT: Discrete Cosine Transformation) の係数 params ------------------------------- returns ------------------------------- 係数 """ cu = 1. cv = 1. if u == 0: cu /= np.sqrt(2) if v == 0: cv /= np.sqrt(2) theta = np.pi / (2 * T) return (( 2 * cu * cv / T) * np.cos((2*x+1)*u*theta) * np.cos((2*y+1)*v*theta)) # DCT def dct(img): """ 離散コサイン変換(DCT: Discrete Cosine Transformation) params ----------------------------- img: numpy.ndarray形式のimage returns ----------------------------- 離散コサイン変換(DCT: Discrete Cosine Transformation) """ # 画像の高さ、幅を取得 H, W, _ = img.shape # 0を要素とする配列を生成する F = np.zeros((H, W, channel), dtype=np.float32) # rgbそれぞれのチャネル for c in range(channel): # 縦方向にT(8)の間隔 for yi in range(0, H, T): # 横方向にT(8)の間隔 for xi in range(0, W, T): for v in range(T): for u in range(T): for y in range(T): for x in range(T): # 各画素に対して離散コサイン変換 F[v+yi, u+xi, c] += img[y+yi, x+xi, c] * w(x,y,u,v) return F # IDCT def idct(F): """ 逆離散コサイン変換 params ----------------------------- F: 離散コサイン変換 returns ----------------------------- 逆離散コサイン変換 """ # 画像の高さ、幅を取得 H, W, _ = F.shape # 0を要素とする配列を生成する out = np.zeros((H, W, channel), dtype=np.float32) for c in range(channel): for yi in range(0, H, T): for xi in range(0, W, T): for y in range(T): for x in range(T): for v in range(K): for u in range(K): out[y+yi, x+xi, c] += F[v+yi, u+xi, c] * w(x,y,u,v) # clipping(NumPy配列ndarrayを任意の最小値・最大値に収めるclip) out = np.clip(out, 0, 255) out = np.round(out).astype(np.uint8) return out # MSE def MSE(img1, img2): """ 平均二乗誤差 params ----------------------------- img1: numpy.ndarray形式のimage img2: numpy.ndarray形式のimage returns ----------------------------- 平均二乗誤差の値 class 'numpy.float64' """ # 画像の高さ、幅を取得 H, W, _ = img1.shape # 二つの画像の差分の二乗 mse = np.sum((img1 - img2) ** 2) / (H * W * channel) # 47.437601725260414 return mse # PSNR def PSNR(mse, vmax=255): """ 信号対雑音比: イメージ間のピーク S/N 比 (PSNR) の計算 params ------------------------------ mse: 平均二乗誤差の値 vmax: 値の最大値で[0,255] returns ------------------------------ 信号対雑音比 class 'numpy.float64' """ return 10 * np.log10(vmax * vmax / mse) # 31.369576363256535 # bitrate def BITRATE(): """ ビットレート class 'float' """ return 1. * T * K * K / T / T #2.0 # DCT F = dct(img) # IDCT out = idct(F) # MSE mse = MSE(img, out) # PSNR psnr = PSNR(mse) # bitrate bitrate = BITRATE() print("MSE:", type(mse)) print("PSNR:", type(psnr)) print("bitrate:", type(bitrate)) # 画像表示 cv2_imshow(out) cv2.waitKey(0) cv2.imwrite("img37.jpg", out)

参考: MathWorksQ.38. JPEG圧縮 (Step.2)DCT+量子化

DCT係数を量子化し、IDCTで復元せよ。また、その時の画像の容量を比べよ。

DCT係数を量子化することはjpeg画像にする符号化で用いられる手法である。

量子化とは、値を予め決定された区分毎に値を大まかに丸め込む作業であり、floorやceil, roundなどが似た計算である。

JPEG画像ではDCT係数を下記で表される量子化テーブルに則って量子化する。 この量子化テーブルはjpeg団体の仕様書から取った。 量子化では8x8の係数をQで割り、四捨五入する。その後Qを掛けることで行われる。 IDCTでは係数は全て用いるものとする。Q = np.array(((16, 11, 10, 16, 24, 40, 51, 61), (12, 12, 14, 19, 26, 58, 60, 55), (14, 13, 16, 24, 40, 57, 69, 56), (14, 17, 22, 29, 51, 87, 80, 62), (18, 22, 37, 56, 68, 109, 103, 77), (24, 35, 55, 64, 81, 104, 113, 92), (49, 64, 78, 87, 103, 121, 120, 101), (72, 92, 95, 98, 112, 100, 103, 99)), dtype=np.float32)量子化を行うと画像の容量が減っていることから、データ量が削減されたことが伺える。

A38# DCT hyoer-parameter T = 8 K = 4 channel = 3 # DCT weight def w(x, y, u, v): """ 離散コサイン変換(DCT: Discrete Cosine Transformation) の係数 params ------------------------------- returns ------------------------------- 係数 """ cu = 1. cv = 1. if u == 0: cu /= np.sqrt(2) if v == 0: cv /= np.sqrt(2) theta = np.pi / (2 * T) return (( 2 * cu * cv / T) * np.cos((2*x+1)*u*theta) * np.cos((2*y+1)*v*theta)) # DCT def dct(img): """ 離散コサイン変換(DCT: Discrete Cosine Transformation) params ----------------------------- img: numpy.ndarray形式のimage returns ----------------------------- 離散コサイン変換(DCT: Discrete Cosine Transformation) """ # 画像の高さ、幅を取得 H, W, _ = img.shape # 0を要素とする配列を生成する F = np.zeros((H, W, channel), dtype=np.float32) # rgbそれぞれのチャネル for c in range(channel): # 縦方向にT(8)の間隔 for yi in range(0, H, T): # 横方向にT(8)の間隔 for xi in range(0, W, T): for v in range(T): for u in range(T): for y in range(T): for x in range(T): # 各画素に対して離散コサイン変換 F[v+yi, u+xi, c] += img[y+yi, x+xi, c] * w(x,y,u,v) return F # IDCT def idct(F): """ 逆離散コサイン変換 params ----------------------------- F: 離散コサイン変換 returns ----------------------------- 逆離散コサイン変換 """ # 画像の高さ、幅を取得 H, W, _ = F.shape # 0を要素とする配列を生成する out = np.zeros((H, W, channel), dtype=np.float32) for c in range(channel): for yi in range(0, H, T): for xi in range(0, W, T): for y in range(T): for x in range(T): for v in range(K): for u in range(K): out[y+yi, x+xi, c] += F[v+yi, u+xi, c] * w(x,y,u,v) # clipping(NumPy配列ndarrayを任意の最小値・最大値に収めるclip) out = np.clip(out, 0, 255) out = np.round(out).astype(np.uint8) return out def quantization(F): """ DCT係数を量子化 params ------------------------------- F: DCT係数 returns ------------------------------- DCT係数を量子化 """ # 画像の高さ、幅を取得 H, W, _ = F.shape # 量子化では8x8の係数をQで割り、四捨五入 Q = np.array(((16, 11, 10, 16, 24, 40, 51, 61), (12, 12, 14, 19, 26, 58, 60, 55), (14, 13, 16, 24, 40, 57, 69, 56), (14, 17, 22, 29, 51, 87, 80, 62), (18, 22, 37, 56, 68, 109, 103, 77), (24, 35, 55, 64, 81, 104, 113, 92), (49, 64, 78, 87, 103, 121, 120, 101), (72, 92, 95, 98, 112, 100, 103, 99)), dtype=np.float32) for ys in range(0, H, T): for xs in range(0, W, T): for c in range(channel): F[ys: ys + T, xs: xs + T, c] = np.round(F[ys: ys + T, xs: xs + T, c] / Q) * Q return F def MSE(img1, img2): """ 平均二乗誤差 params ----------------------------- img1: numpy.ndarray形式のimage img2: numpy.ndarray形式のimage returns ----------------------------- 平均二乗誤差の値 class 'numpy.float64' """ # 画像の高さ、幅を取得 H, W, _ = img1.shape # 二つの画像の差分の二乗 mse = np.sum((img1 - img2) ** 2) / (H * W * channel) return mse # PSNR def PSNR(mse, vmax=255): """ 信号対雑音比: イメージ間のピーク S/N 比 (PSNR) の計算 params ------------------------------ mse: 平均二乗誤差の値 vmax: 値の最大値で[0,255] returns ------------------------------ 信号対雑音比 class 'numpy.float64' """ return 10 * np.log10(vmax * vmax / mse) def BITRATE(): """ ビットレート class 'float' """ return 1. * T * K * K / T / T # DCT F = dct(img) # quantization F = quantization(F) # IDCT out = idct(F) # MSE mse = MSE(img, out) # PSNR psnr = PSNR(mse) # bitrate bitrate = BITRATE() print("MSE:", mse) print("PSNR:", psnr) print("bitrate:", bitrate) # 画像表示 cv2_imshow(out) cv2.waitKey(0) cv2.imwrite("img38.jpg", out)

参考: 量子化行列のナゾ~その1Q.39. JPEG圧縮 (Step.3)YCbCr表色系

YCbCr表色形において、Yを0.7倍してコントラストを暗くせよ。

YCbCr表色系とは、画像を明るさを表すY、輝度と青レベルの差Cb、輝度と赤レベルの差Crに分解する表現方法である。

これはJPEG変換で用いられる。A39def y_change(img, y): """ brg => YCrCbへ変換し、コントラストを変える YCrCb => bgrへ変換 params --------------------------------- img: numpy.ndarray形式のimage y: yのコントラストの数値(倍数) returns --------------------------------- numpy.ndarray形式のimage """ # rgb => YCrCbへ変換 YCrCb = cv2.cvtColor(img, cv2.COLOR_BGR2YCR_CB) # Yを0.7倍 YCrCb[..., 0] = YCrCb[..., 0] * 0.7 # YCrCb => bgrへ変換 out = cv2.cvtColor(YCrCb, cv2.COLOR_YCrCb2BGR) return out # YCbCr表色系 out = y_change(img, 0.7) # 保存 cv2_imshow(out) cv2.waitKey(0) cv2.imwrite("img39.jpg", out)

参考: Python OpenCV:YCbCrをRGBに戻す方法は?Q.40. JPEG圧縮 (Step.4)YCbCr+DCT+量子化

YCbCr表色系にし、DCT後、Yを量子化テーブルQ1、CbとCrをQ2で量子化し、IDCTで画像を復元せよ。 また、画像の容量を比較せよ。

アルゴリズムは、

1. RGB を YCbCrに変換

2. YCbCrをDCT

3. DCTしたものを量子化

4. 量子化したものをIDCT

5. IDCTしたYCbCrをRGBに変換

これはJPEGで実際に使われるデータ量削減の手法であり、Q1,Q2はJPEGの仕様書に則って次式で定義される。A40def BGR2YCbCr(img): """ bgr => YCrCbへ変換 params --------------------------------- img: numpy.ndarray形式のimage returns --------------------------------- numpy.ndarray形式のimage """ # rgb => YCrCbへ変換 YCrCb = cv2.cvtColor(img, cv2.COLOR_BGR2YCR_CB) return YCrCb def YCbCr2BGR(img): """ YCbCr => bgrへ変換 params --------------------------------- img: numpy.ndarray形式のimage returns --------------------------------- numpy.ndarray形式のimage """ # YCbCr => bgへ変換 bgr = cv2.cvtColor(YCrCb, cv2.COLOR_YCrCb2BGR) return bgr # DCT hyoer-parameter T = 8 K = 4 channel = 3 # DCT weight def w(x, y, u, v): """ 離散コサイン変換(DCT: Discrete Cosine Transformation) の係数 params ------------------------------- returns ------------------------------- 係数 """ cu = 1. cv = 1. if u == 0: cu /= np.sqrt(2) if v == 0: cv /= np.sqrt(2) theta = np.pi / (2 * T) return (( 2 * cu * cv / T) * np.cos((2*x+1)*u*theta) * np.cos((2*y+1)*v*theta)) # DCT def dct(img): """ 離散コサイン変換(DCT: Discrete Cosine Transformation) params ----------------------------- img: numpy.ndarray形式のimage returns ----------------------------- 離散コサイン変換(DCT: Discrete Cosine Transformation) """ # 画像の高さ、幅を取得 H, W, _ = img.shape # 0を要素とする配列を生成する F = np.zeros((H, W, channel), dtype=np.float32) # rgbそれぞれのチャネル for c in range(channel): # 縦方向にT(8)の間隔 for yi in range(0, H, T): # 横方向にT(8)の間隔 for xi in range(0, W, T): for v in range(T): for u in range(T): for y in range(T): for x in range(T): # 各画素に対して離散コサイン変換 F[v+yi, u+xi, c] += img[y+yi, x+xi, c] * w(x,y,u,v) return F # IDCT def idct(F): """ 逆離散コサイン変換 params ----------------------------- F: 離散コサイン変換 returns ----------------------------- 逆離散コサイン変換 """ # 画像の高さ、幅を取得 H, W, _ = F.shape # 0を要素とする配列を生成する out = np.zeros((H, W, channel), dtype=np.float32) for c in range(channel): for yi in range(0, H, T): for xi in range(0, W, T): for y in range(T): for x in range(T): for v in range(K): for u in range(K): out[y+yi, x+xi, c] += F[v+yi, u+xi, c] * w(x,y,u,v) # clipping(NumPy配列ndarrayを任意の最小値・最大値に収めるclip) out = np.clip(out, 0, 255) out = np.round(out).astype(np.uint8) return out def quantization(F): """ DCT係数を量子化 params ------------------------------- F: DCT係数 returns ------------------------------- DCT係数を量子化 """ # 画像の高さ、幅を取得 H, W, _ = F.shape # 量子化では8x8の係数をQで割り、四捨五入 Q = np.array(((16, 11, 10, 16, 24, 40, 51, 61), (12, 12, 14, 19, 26, 58, 60, 55), (14, 13, 16, 24, 40, 57, 69, 56), (14, 17, 22, 29, 51, 87, 80, 62), (18, 22, 37, 56, 68, 109, 103, 77), (24, 35, 55, 64, 81, 104, 113, 92), (49, 64, 78, 87, 103, 121, 120, 101), (72, 92, 95, 98, 112, 100, 103, 99)), dtype=np.float32) for ys in range(0, H, T): for xs in range(0, W, T): for c in range(channel): F[ys: ys + T, xs: xs + T, c] = np.round(F[ys: ys + T, xs: xs + T, c] / Q) * Q return F def JPEG(img): """ jpeg圧縮 params ------------------------------------ img: numpy.ndarray形式のimage returns ------------------------------------ numpy.ndarray形式のimage """ # BGR -> YCbCr YCbCr = BGR2YCbCr(img) # DCT F = dct(YCbCr) # DCT係数を量子化 F = quantization(F) # IDCT YCbCr = idct(F) # Y Cb Cr -> BGR out = YCbCr2BGR(YCbCr) return out def MSE(img1, img2): """ 平均二乗誤差 params ----------------------------- img1: numpy.ndarray形式のimage img2: numpy.ndarray形式のimage returns ----------------------------- 平均二乗誤差の値 class 'numpy.float64' """ # 画像の高さ、幅を取得 H, W, _ = img1.shape # 二つの画像の差分の二乗 mse = np.sum((img1 - img2) ** 2) / (H * W * channel) return mse # PSNR def PSNR(mse, vmax=255): """ 信号対雑音比: イメージ間のピーク S/N 比 (PSNR) の計算 params ------------------------------ mse: 平均二乗誤差の値 vmax: 値の最大値で[0,255] returns ------------------------------ 信号対雑音比 class 'numpy.float64' """ return 10 * np.log10(vmax * vmax / mse) def BITRATE(): """ ビットレート class 'float' """ return 1. * T * K * K / T / T # JPEG out = JPEG(img) # MSE mse = MSE(img, out) # PSNR psnr = PSNR(mse) # bitrate bitrate = BITRATE() print("MSE:", mse) print("PSNR:", psnr) print("bitrate:", bitrate) # 画像表示 cv2_imshow(out) cv2.waitKey(0) cv2.imwrite("img40.jpg", out)感想

内容が賀くんと難しくなった。うまく説明できていない部分は随時更新していく

- 投稿日:2020-12-01T23:05:20+09:00

表示されたファイル内の固有表現リスト(人名、地名など)から単語選択する、該当する「主語 -> 述語」ペアが一覧表示されるGUIツール

作ったもの

Terminal% python3 tkinter_ner_sub_pred_pair_file_dialog.py1. 以下のウインドウが立ち上がります。

ファイル選択ダイアログが現れます。

"OK"を押して、任意のディレクトリから任意のテキストファイルを選択します。__

ファイル選択ダイアログの表示が、以下に変わります。

以下の画面が表示されます。

「地名」のラジオボタンを選択し、「ファイルから指定した・・・」ボタンを押す。

( 出力画面を下方向にスクロールすると、画面切れしていた解析結果の続きを確認できる )

『着目する「主語」』欄に「5」(「中国」)を入力後、「指定単語を主語に持つ・・・」ボタンを押す。

( 出力画面を下方向にスクロールすると、画面の外に表示されている解析結果を確認できる )

『着目する「主語」』欄に「2」(「ロシア」)を入力後、「指定単語を主語に持つ・・・」ボタンを押す。

『着目する「主語」』欄に「4」(「日本」)を入力後、「指定単語を主語に持つ・・・」ボタンを押す。

「組織名」のラジオボタンを選択し、「ファイルから指定した・・・」ボタンを押す。

『着目する「主語」』欄に「1」(「ロシア軍」)を入力後、「指定単語を主語に持つ・・・」ボタンを押す。

今回、ツールに読み込ませたファイル(拡張子:".txt") )

NHK NewsWebの国際面に、2020/12/1に掲載されていた記事を読み込ませてみました。

article.txtACロシア軍は、北方領土で地対空ミサイルシステム「S300」の訓練を初めて行ったと発表しました。ロシアとしては北方領土で軍備を強化している姿勢を強調するねらいがあるものとみられます。 ロシア軍の東部軍管区は1日、地対空ミサイルシステム「S300」の訓練を北方領土を含む島々で初めて行ったと発表しました。 このミサイルシステムは中国国境に近いロシア極東のユダヤ自治州に配備されていたものを移送したということで、軍のテレビ局は、北方領土の択捉島でミサイルシステムを稼働させる映像を流しました。 このミサイルシステムは、射程がおよそ400キロ、戦闘機やミサイルなどを撃ち落とす対空防衛を目的としていて、島にある演習場で訓練することが目的だとしています。 ロシアは、択捉島と国後島には地対艦ミサイルシステムを配備していますが、「S300」の訓練を北方領土で行ったのは初めてで、ロシアとしては、北方領土で軍備を強化している姿勢を強調するねらいがあるものとみられます。 日本政府は、ロシア側による北方領土での軍備の強化について「北方領土に関する日本の立場と相いれず受け入れられない」として繰り返し、抗議しています。

実装コード

tkinter_ner_sub_pred_pair_file_dialog.py# Tkinterのライブラリを取り込む import tkinter, spacy, collections, CaboCha, os import tkinter.filedialog, tkinter.messagebox from typing import List, TypeVar from tkinter import * from tkinter import ttk from tkinter import filedialog from tkinter import messagebox from spacy.matcher import Matcher # グローバル変数の宣言 exracted_entity_word_list = "" user_input_text = "" named_entity_label = "" T = TypeVar('T', str, None) Vector = List[T] # ファイルの参照処理 def click_refer_button(): fTyp = [("","*")] iDir = os.path.abspath(os.path.dirname(__file__)) filepath = filedialog.askopenfilename(filetypes = fTyp, initialdir = iDir) file_path.set(filepath) # 固有表現抽出処理 def extract_words_by_entity_label(text, named_entity_label): nlp = spacy.load('ja_ginza') text = text.replace("\n", "") doc = nlp(text) words_list = [ent.text for ent in doc.ents if ent.label_ == named_entity_label] return words_list # 出力処理 def click_export_button(): # 選択された固有表現の種別名を取得 named_entity_label = flg.get() global user_input_text f = open(file_path, encoding="utf-8") user_input_text = f.read() label_word_list = extract_words_by_entity_label(user_input_text, named_entity_label) # 指定された固有表現に該当する単語を取得した結果(単語リスト)を、{単語文字列 : 出現回数}の辞書に変換する count_per_word = collections.Counter(label_word_list) # 出現回数の多い順番に並べる freq_per_word_dict = dict(count_per_word.most_common()) #output_list = ["{k} : {v}".format(k=key, v=value) for (key, value) in freq_per_word_dict.items()] # 単語数を取得する unique_word_num = len(freq_per_word_dict) if unique_word_num > 0: message = "{num}件の{label}が見つかりました。\n\n出現回数順に並べた結果は以下です。\n\n".format(num=unique_word_num, label=named_entity_label) word_list = list(freq_per_word_dict.keys()) word_freq_list = list(freq_per_word_dict.values()) for i in range(unique_word_num): tmp = "{rank}番目の単語 : {word}\n出現回数 : {count}\n\n===================\n".format(rank=i+1, word=word_list[i], count=word_freq_list[i]) message += tmp else: message = "{num}件の{label}が見つかりました。\n\n".format(num=unique_word_num, label=named_entity_label) textBox.insert(END, message) global exracted_entity_word_list exracted_entity_word_list = word_list return exracted_entity_word_list def get_subject_predicate_pair_list(sentence: str, subject_word: str) -> Vector: T = TypeVar('T', str, None) c = CaboCha.Parser() tree = c.parse(sentence) # 形態素を結合しつつ[{c:文節, to:係り先id}]の形に変換する chunks = [] text = "" toChunkId = -1 for i in range(0, tree.size()): token = tree.token(i) text = token.surface if token.chunk else (text + token.surface) toChunkId = token.chunk.link if token.chunk else toChunkId # 文末かchunk内の最後の要素のタイミングで出力 if i == tree.size() - 1 or tree.token(i+1).chunk: chunks.append({'c': text, 'to': toChunkId}) # ループの中で出力される「係り元→係り先」文字列をlistに格納 pair_list = [] # for chunk in chunks: if chunk['to'] >= 0: pair_list.append(chunk['c'] + " → " + chunks[chunk['to']]['c']) output_list = [pair for pair in pair_list if subject_word in pair] return output_list def click_export_button2(): # 入力された主語単語の文字列を取得 order_num = int(subject_num.get())-1 #ユーザが1を入力したとき、配列の0番地を指定する。 subject_string = exracted_entity_word_list[order_num] output_list = get_subject_predicate_pair_list(user_input_text, subject_string) result = "\n".join(output_list) message = """ 単語:「{subject_word}」を主語に持つ「主語と述語」のペアは、以下が見つかりました。 ========================================================================= {result} ========================================================================= 以上です。 """.format(subject_word=subject_string, result=result) textBox.insert(END, message) if __name__ == '__main__': # ウィンドウを作成 root = tkinter.Tk() root.title("文書内容_早見チェッカー") # アプリの名前 root.geometry("730x500") # アプリの画面サイズ # ファイル選択ウインドウを作成 # root.withdraw() fTyp = [("", "*.txt")] iDir = os.path.abspath(os.path.dirname(__file__)) tkinter.messagebox.showinfo('ファイル選択ダイアログ','処理ファイルを選択してください!') file_path = tkinter.filedialog.askopenfilename(filetypes = fTyp,initialdir = iDir) # 処理ファイル名の出力 tkinter.messagebox.showinfo('以下のファイルを選択しました。',file_path) # Frame1の作成 frame1 = ttk.Frame(root, padding=10) frame1.grid() # 「」ラベルの作成 t = StringVar() t.set('着目する「主語」:') label1 = ttk.Label(frame1, textvariable=t) label1.grid(row=1, column=0) #テキストボックス2(「主語述語ペア」の「主語」入力欄)の作成 subject_num = StringVar() subject_num_entry = ttk.Entry(frame1, textvariable=subject_num, width=50) subject_num_entry.grid(row=1, column=1) # ラジオボタンの作成 #共有変数 flg= StringVar() #ラジオ1 rb1 = ttk.Radiobutton(frame1, text='人名',value="PERSON", variable=flg) rb1.grid(row=2,column=0) #ラジオ2 rb2 = ttk.Radiobutton(frame1, text='地名',value="LOC", variable=flg) rb2.grid(row=2,column=1) #ラジオ3 rb3 = ttk.Radiobutton(frame1, text='組織名', value="ORG", variable=flg) rb3.grid(row=2,column=2) #ラジオ4 rb4 = ttk.Radiobutton(frame1, text='日付',value="DATE", variable=flg) rb4.grid(row=3,column=0) #ラジオ5 rb5 = ttk.Radiobutton(frame1, text='イベント名',value="EVENT", variable=flg) rb5.grid(row=3,column=1) #ラジオ6 rb6 = ttk.Radiobutton(frame1, text='金額',value="MONEY", variable=flg) rb6.grid(row=3,column=2) # Frame2の作成 frame2= ttk.Frame(root, padding=10) frame2.grid() # 固有表現単語を抽出した結果を表示させるボタンの作成 export_button = ttk.Button(frame2, text='ファイルから指定した種類の単語を洗い出す', command=click_export_button, width=70) export_button.grid(row=0, column=0) # 「主語述語ペア」を抽出した結果を表示させるボタンの作成 export_button2 = ttk.Button(frame2, text='指定単語を主語に持つ「主語述語ペア」を表示します', command=click_export_button2, width=70) export_button2.grid(row=1, column=0) # テキスト出力ボックスの作成 textboxname = StringVar() textboxname.set('\n\n処理結果 ') label3 = ttk.Label(frame2, textvariable=textboxname) label3.grid(row=1, column=0) textBox = Text(frame2, width=100) textBox.grid(row=3, column=0) file_selected_message = """以下のファイルを選択しました。\n{filename}\n\n""".format(filename=file_path) textBox.insert(END, file_selected_message) # ウィンドウを動かす root.mainloop()

- 投稿日:2020-12-01T23:05:20+09:00

ファイルに登場する固有表現リストを表示後、選択した単語が起点となる「主語 -> 述語」ペアを一覧表示するGUIツール

作ったもの

Terminal% python3 tkinter_ner_sub_pred_pair_file_dialog.py1. 以下のウインドウが立ち上がります。

ファイル選択ダイアログが現れます。

"OK"を押して、任意のディレクトリから任意のテキストファイルを選択します。

ファイル選択ダイアログの表示が、以下に変わります。

以下の画面が表示されます。

「地名」のラジオボタンを選択し、「ファイルから指定した・・・」ボタンを押す。

( 出力画面を下方向にスクロールすると、画面切れしていた解析結果の続きを確認できる )

『着目する「主語」』欄に「5」(「中国」)を入力後、「指定単語を主語に持つ・・・」ボタンを押す。

( 出力画面を下方向にスクロールすると、画面の外に表示されている解析結果を確認できる )

『着目する「主語」』欄に「2」(「ロシア」)を入力後、「指定単語を主語に持つ・・・」ボタンを押す。

『着目する「主語」』欄に「4」(「日本」)を入力後、「指定単語を主語に持つ・・・」ボタンを押す。

「組織名」のラジオボタンを選択し、「ファイルから指定した・・・」ボタンを押す。

『着目する「主語」』欄に「1」(「ロシア軍」)を入力後、「指定単語を主語に持つ・・・」ボタンを押す。

今回、ツールに読み込ませたファイル(拡張子:".txt") )

NHK NewsWebの国際面に、2020/12/1に掲載されていた記事を読み込ませてみました。

article.txtロシア軍は、北方領土で地対空ミサイルシステム「S300」の訓練を初めて行ったと発表しました。ロシアとしては北方領土で軍備を強化している姿勢を強調するねらいがあるものとみられます。 ロシア軍の東部軍管区は1日、地対空ミサイルシステム「S300」の訓練を北方領土を含む島々で初めて行ったと発表しました。 このミサイルシステムは中国国境に近いロシア極東のユダヤ自治州に配備されていたものを移送したということで、軍のテレビ局は、北方領土の択捉島でミサイルシステムを稼働させる映像を流しました。 このミサイルシステムは、射程がおよそ400キロ、戦闘機やミサイルなどを撃ち落とす対空防衛を目的としていて、島にある演習場で訓練することが目的だとしています。 ロシアは、択捉島と国後島には地対艦ミサイルシステムを配備していますが、「S300」の訓練を北方領土で行ったのは初めてで、ロシアとしては、北方領土で軍備を強化している姿勢を強調するねらいがあるものとみられます。 日本政府は、ロシア側による北方領土での軍備の強化について「北方領土に関する日本の立場と相いれず受け入れられない」として繰り返し、抗議しています。

実装コード

tkinter_ner_sub_pred_pair_file_dialog.py# Tkinterのライブラリを取り込む import tkinter, spacy, collections, CaboCha, os import tkinter.filedialog, tkinter.messagebox from typing import List, TypeVar from tkinter import * from tkinter import ttk from tkinter import filedialog from tkinter import messagebox from spacy.matcher import Matcher # グローバル変数の宣言 exracted_entity_word_list = "" user_input_text = "" named_entity_label = "" T = TypeVar('T', str, None) Vector = List[T] # ファイルの参照処理 def click_refer_button(): fTyp = [("","*")] iDir = os.path.abspath(os.path.dirname(__file__)) filepath = filedialog.askopenfilename(filetypes = fTyp, initialdir = iDir) file_path.set(filepath) # 固有表現抽出処理 def extract_words_by_entity_label(text, named_entity_label): nlp = spacy.load('ja_ginza') text = text.replace("\n", "") doc = nlp(text) words_list = [ent.text for ent in doc.ents if ent.label_ == named_entity_label] return words_list # 出力処理 def click_export_button(): # 選択された固有表現の種別名を取得 named_entity_label = flg.get() global user_input_text f = open(file_path, encoding="utf-8") user_input_text = f.read() label_word_list = extract_words_by_entity_label(user_input_text, named_entity_label) # 指定された固有表現に該当する単語を取得した結果(単語リスト)を、{単語文字列 : 出現回数}の辞書に変換する count_per_word = collections.Counter(label_word_list) # 出現回数の多い順番に並べる freq_per_word_dict = dict(count_per_word.most_common()) #output_list = ["{k} : {v}".format(k=key, v=value) for (key, value) in freq_per_word_dict.items()] # 単語数を取得する unique_word_num = len(freq_per_word_dict) if unique_word_num > 0: message = "{num}件の{label}が見つかりました。\n\n出現回数順に並べた結果は以下です。\n\n".format(num=unique_word_num, label=named_entity_label) word_list = list(freq_per_word_dict.keys()) word_freq_list = list(freq_per_word_dict.values()) for i in range(unique_word_num): tmp = "{rank}番目の単語 : {word}\n出現回数 : {count}\n\n===================\n".format(rank=i+1, word=word_list[i], count=word_freq_list[i]) message += tmp else: message = "{num}件の{label}が見つかりました。\n\n".format(num=unique_word_num, label=named_entity_label) textBox.insert(END, message) global exracted_entity_word_list exracted_entity_word_list = word_list return exracted_entity_word_list def get_subject_predicate_pair_list(sentence: str, subject_word: str) -> Vector: T = TypeVar('T', str, None) c = CaboCha.Parser() tree = c.parse(sentence) # 形態素を結合しつつ[{c:文節, to:係り先id}]の形に変換する chunks = [] text = "" toChunkId = -1 for i in range(0, tree.size()): token = tree.token(i) text = token.surface if token.chunk else (text + token.surface) toChunkId = token.chunk.link if token.chunk else toChunkId # 文末かchunk内の最後の要素のタイミングで出力 if i == tree.size() - 1 or tree.token(i+1).chunk: chunks.append({'c': text, 'to': toChunkId}) # ループの中で出力される「係り元→係り先」文字列をlistに格納 pair_list = [] # for chunk in chunks: if chunk['to'] >= 0: pair_list.append(chunk['c'] + " → " + chunks[chunk['to']]['c']) output_list = [pair for pair in pair_list if subject_word in pair] return output_list def click_export_button2(): # 入力された主語単語の文字列を取得 order_num = int(subject_num.get())-1 #ユーザが1を入力したとき、配列の0番地を指定する。 subject_string = exracted_entity_word_list[order_num] output_list = get_subject_predicate_pair_list(user_input_text, subject_string) result = "\n".join(output_list) message = """ 単語:「{subject_word}」を主語に持つ「主語と述語」のペアは、以下が見つかりました。 ========================================================================= {result} ========================================================================= 以上です。 """.format(subject_word=subject_string, result=result) textBox.insert(END, message) if __name__ == '__main__': # ウィンドウを作成 root = tkinter.Tk() root.title("文書内容_早見チェッカー") # アプリの名前 root.geometry("730x500") # アプリの画面サイズ # ファイル選択ウインドウを作成 # root.withdraw() fTyp = [("", "*.txt")] iDir = os.path.abspath(os.path.dirname(__file__)) tkinter.messagebox.showinfo('ファイル選択ダイアログ','処理ファイルを選択してください!') file_path = tkinter.filedialog.askopenfilename(filetypes = fTyp,initialdir = iDir) # 処理ファイル名の出力 tkinter.messagebox.showinfo('以下のファイルを選択しました。',file_path) # Frame1の作成 frame1 = ttk.Frame(root, padding=10) frame1.grid() # 「」ラベルの作成 t = StringVar() t.set('着目する「主語」:') label1 = ttk.Label(frame1, textvariable=t) label1.grid(row=1, column=0) #テキストボックス2(「主語述語ペア」の「主語」入力欄)の作成 subject_num = StringVar() subject_num_entry = ttk.Entry(frame1, textvariable=subject_num, width=50) subject_num_entry.grid(row=1, column=1) # ラジオボタンの作成 #共有変数 flg= StringVar() #ラジオ1 rb1 = ttk.Radiobutton(frame1, text='人名',value="PERSON", variable=flg) rb1.grid(row=2,column=0) #ラジオ2 rb2 = ttk.Radiobutton(frame1, text='地名',value="LOC", variable=flg) rb2.grid(row=2,column=1) #ラジオ3 rb3 = ttk.Radiobutton(frame1, text='組織名', value="ORG", variable=flg) rb3.grid(row=2,column=2) #ラジオ4 rb4 = ttk.Radiobutton(frame1, text='日付',value="DATE", variable=flg) rb4.grid(row=3,column=0) #ラジオ5 rb5 = ttk.Radiobutton(frame1, text='イベント名',value="EVENT", variable=flg) rb5.grid(row=3,column=1) #ラジオ6 rb6 = ttk.Radiobutton(frame1, text='金額',value="MONEY", variable=flg) rb6.grid(row=3,column=2) # Frame2の作成 frame2= ttk.Frame(root, padding=10) frame2.grid() # 固有表現単語を抽出した結果を表示させるボタンの作成 export_button = ttk.Button(frame2, text='ファイルから指定した種類の単語を洗い出す', command=click_export_button, width=70) export_button.grid(row=0, column=0) # 「主語述語ペア」を抽出した結果を表示させるボタンの作成 export_button2 = ttk.Button(frame2, text='指定単語を主語に持つ「主語述語ペア」を表示します', command=click_export_button2, width=70) export_button2.grid(row=1, column=0) # テキスト出力ボックスの作成 textboxname = StringVar() textboxname.set('\n\n処理結果 ') label3 = ttk.Label(frame2, textvariable=textboxname) label3.grid(row=1, column=0) textBox = Text(frame2, width=100) textBox.grid(row=3, column=0) file_selected_message = """以下のファイルを選択しました。\n{filename}\n\n""".format(filename=file_path) textBox.insert(END, file_selected_message) # ウィンドウを動かす root.mainloop()

- 投稿日:2020-12-01T22:54:40+09:00

NVIDIA Triton Inference Server で推論してみた

はじめに

こんにちは。 @dcm_yamaya です。

ことしハマったキーボードは HHKB Professional HYBRID (not type-s) です。

この記事は、NTTドコモ R&D Advent Calendar 2020 7日目の記事です。

普段の業務では、画像認識やエッジコンピューティングの技術領域を担当しています。

昨年の記事 ではJetson上で画像認識モデルをTensorRT化する方法を紹介しました。

ことしはTensorRTに関連して興味があった、GTC2020で発表された NVIDIA Triton Inference Server を使って画像認識モデルの推論を試したいと思います。

「あれ、このフレームワーク前もなかったっけ?TensorRT Inference Server じゃなかったっけ?」

と思ったら、名前が変わっていました。

https://twitter.com/_ksasaki/status/1243708356419710976?s=20対象とする人

- GPUサーバで

- Triton Inference Server を使ってみたい

やること

- Triton Inference Server とは

- 分類モデルの推論

- 物体検出モデル(yolov3)の推論

Triton Inference Server で推論してみよう

Triton Inference Server とは

NVIDIA がリリースしている、GPUを使用して機械学習モデルを高速に推論させるサーバを構築するためのフレームワークです。

単に推論させるだけであれば、わざわざをサーバを立てなくても…という気もしますが、TISによって複数の学習環境の異なるモデルを高速に

動作させることができるといったメリットがあります。

Inference Server に載せたモデルを推論するには、クライアントからHTTP/RESTまたはGRPCプロトコルでリクエストを投げることで、

推論結果を得ることができます。TensorFlowはTensorFlow Serving, Pytorch は TorchServe と フレームワークごとに Serving が用意されていますが、それらとは異なりTensorRTが使えるなどより実行を高速にできる(可能性がある)のがこれらとのちがいかなと思います。

※[2]

特徴

- 様々なフレームワークで学習されたモデルを扱うことができる

- TensorRT

- TensorFlow GraphDef

- TensorFlow SavedModel

- ONNX

- Pytorch TorchScript

- 複数のモデルを同時に、1つのGPU内または複数のGPU上で実行できる(Concurent Execution)

- GPUごとに使用率やメモリ、レイテンシーの状況など各種メトリクスの監視ができる

分類モデルの推論

では早速 Triton Inference Server を使って推論してみたいと思います。

こちらにチュートリアルがあるのでこれを参考に画像分類モデルの推論を試してみます。

特にTensorRTがUbuntuやCUDAのバージョンにシビアなため、それにあったTISのバージョンを選択する必要があることが注意点です。

(筆者は最初にはまりました。。)

https://github.com/triton-inference-server/server/blob/master/docs/quickstart.md筆者の動作環境

- Docker version 19.03.13

- Ubuntu 18.04

- CUDA 10.2

- TensorRT 6.0.1.8

Docker Image のインストール

下記コマンドでngcから docker image を pull してきます。

docker pull nvcr.io/nvidia/tritonserver:<xx.yy>-py3

<xx.yy>の部分はバージョンとなっていて、Ubuntu、CUDA、TensorRTのバージョンに合わせて選択します。

リリースノートを参照しながら、筆者環境では20.03を選択しました。$ docker pull nvcr.io/nvidia/tritonserver:20.03-py3model repositoryの作成

サンプルとしていくつかモデルがダウンロードできるようになっているので、githubのコードから

./fetch_models.shを実行します。これにより複数個のモデルが配置されます。git clone https://github.com/NVIDIA/triton-inference-server cd triton-inference-server git checkout r20.03 cd docs/examples ./fetch_models.shTriton Server で推論したいモデルは model repository に置きますが、その位置は

docs/example/model_repositoryになります。サーバの実行

まずはサーバを立ち上げます。以下のコマンドで

/modelsに model_repository をマウントできるようにします。cd triton-inference-server docker run --gpus=1 --rm -p 8000:8000 -p 8001:8001 -p 8002:8002 -v $PWD/docs/examples/model_repository:/models nvcr.io/nvidia/tritonserver:20.03-py3 trtserver --model-repository=/models注意するのは、20.03までは

trtserverという名前で、以降はtritonserverな点です。これでGPUの認識及び model_repository 以下にあるモデルがGPU上に展開されるログが表示されていると思います。最後にhttpserviceなど3つのサーバがスタートしていることが表示されればOKです。============================= == Triton Inference Server == ============================= NVIDIA Release 20.03 (build 11042949) Copyright (c) 2018-2019, NVIDIA CORPORATION. All rights reserved. Various files include modifications (c) NVIDIA CORPORATION. All rights reserved. NVIDIA modifications are covered by the license terms that apply to the underlying project or file. 2020-11-29 11:05:38.961638: I tensorflow/stream_executor/platform/default/dso_loader.cc:44] Successfully opened dynamic library libcudart.so.10.2 I1129 11:05:39.008650 1 metrics.cc:164] found 1 GPUs supporting NVML metrics I1129 11:05:39.014088 1 metrics.cc:173] GPU 0: Quadro P6000 I1129 11:05:39.014403 1 server.cc:120] Initializing Triton Inference Server I1129 11:05:39.334589 1 server_status.cc:55] New status tracking for model 'densenet_onnx' I1129 11:05:39.334616 1 server_status.cc:55] New status tracking for model 'inception_graphdef' I1129 11:05:39.334640 1 server_status.cc:55] New status tracking for model 'simple' ... Starting endpoints, 'inference:0' listening on I1129 11:05:42.585518 1 grpc_server.cc:1939] Started GRPCService at 0.0.0.0:8001 I1129 11:05:42.585571 1 http_server.cc:1411] Starting HTTPService at 0.0.0.0:8000 I1129 11:05:42.629039 1 http_server.cc:1426] Starting Metrics Service at 0.0.0.0:8002これでAPIの状態などをチェックすることができます。

curl localhost:8000/api/status id: "inference:0" version: "1.12.0" uptime_ns: 6718051588331 model_status { key: "densenet_onnx" value { config { name: "densenet_onnx" platform: "onnxruntime_onnx" version_policy { latest { num_versions: 1 } } input { name: "data_0" data_type: TYPE_FP32 format: FORMAT_NCHW dims: 3 dims: 224 dims: 224 reshape { ...クライアントの実行

次にクライアント側を実行します。

docker pull nvcr.io/nvidia/tritonserver:20.03-py3-sdk docker run --rm --net=host -it nvcr.io/nvidia/tritonserver:20.03-py3-clientsdkコンテナに入ることができたら、pythonコードを実行し、画像の分類モデルのリクエストを投げて結果を表示してみます。

python /workspace/install/python/image_client.py -m densenet_onnx -c 3 -s INCEPTION /workspace/images/mug.jpg Request 0, batch size 1 Image ‘/workspace/images/mug.jpg’: 504 (COFFEE MUG) = 13.901954650878906 968 (CUP) = 12.000585556030273 967 (ESPRESSO) = 9.819758415222168これでdensenetによる画像分類ができ、

/workspace/images/mug.jpgに対しCOFFEE MUGの画像と推論ができました。

image_client.pyでは、引数でモデルを指定しています。-mでdensenetモデルを選択肢、-cで上位3つの結果を返すように設定しています。

これで、サーバ側とクライアント側の動きを試すことができました。モデルの配置の仕方

新しいモデルを配置してサーバで読むにはどうするのか?というとmodel_repositoryに設定されたルールやパスを記述して読み込ませることができます。

docs/example/model_repositoryがそのまま参考になりますが、こういった構成で配置することになります。models/ +-- densenet_onnx # モデルの名前 | +-- config.pbtxt # 設定ファイル | +-- output_labels_file.txt # クラス名のファイル | +-- 1/ # バージョン | +-- saved_model.pb ...モデル名のフォルダの下に、設定ファイルとバージョンを示すフォルダがあり、そのフォルダの下にバイナリファイル(重みパラメータであるモデルファイル)を配置します。設定ファイルは、例えばdensenet_onnxの場合はこのように記述されています。

name: "densenet_onnx" platform: "onnxruntime_onnx" max_batch_size : 0 input [ { name: "data_0" data_type: TYPE_FP32 format: FORMAT_NCHW dims: [ 3, 224, 224 ] reshape { shape: [ 1, 3, 224, 224 ] } } ] output [ { name: "fc6_1" data_type: TYPE_FP32 dims: [ 1000 ] reshape { shape: [ 1, 1000, 1, 1 ] } label_filename: "densenet_labels.txt" } ]入力と出力の形式を記述するのはもちろん、platformでモデル自体の形式を指定します。TensorRT化されたモデルであればtensorrt_plan、TFのsaved_modelであればtensorflow_savedmodelと記載します。

このようにしてモデルを配置したらもう一度サーバ側のdockerコンテナを立ち上げることで、新しく配置したモデルが読み込まれリクエストを投げて推論することができます。物体検出モデルの推論

次に、分類モデル以外の例として、みんな大好き物体検出アルゴリズムyolov3をTISに載せて推論してみます。

学習のフレームワークとしてdarknetで学習したモデルをTensorFlowのsavedmodelとしてpbで読み込む方法と、TensorRT化した上でデプロイする2つ方法がありますが、今回は前者でやってみようと思います。モデルの設定

今回のモデルはTensorFlowの savedmodel を使うこととします。この場合はdarknetの重みからpbへ変換して上げる必要がありますが、その部分は下記レポジトリが参考になります。

https://github.com/zzh8829/yolov3-tf2TensorFlow Serving の例でexportできる部分があるので、これをもとにpb化してきます。

python export_tfserving.py --output serving/yolov3/1/続いて、yolov3のモデルを配置するにあたり、設定ファイルを書く必要があります。yolov3.pbtxtはこんな感じで書くことができます。モデル名(フォルダ名)は

yolov3_tfとしています。name: "yolov3_tf" platform: "tensorflow_savedmodel" max_batch_size: 64 input [ { name: "input_1" data_type: TYPE_FP32 dims: -1 dims: -1 dims: 3 } ] output [ { name: "yolo_nms_0" data_type: TYPE_FP32 dims: -1 dims: 1 dims: 4 }, { name: "yolo_nms_1" data_type: TYPE_FP32 dims: -1 dims: -1 }, { name: "yolo_nms_2" data_type: TYPE_FP32 dims: -1 dims: -1 } ] instance_group [ { kind: KIND_GPU count: 1 gpus: [0] # 使用するGPUの指定 } ]最後の

instance_groupではCPU/GPUどちらで実行するのか、GPUの場合どのGPUで何並列で実行するのかを設定できます。ここまでできたら、サーバ側でyolov3モデルを読み込むよう再度立ち上げます。

docker run --gpus=1 --rm -p 8000:8000 -p 8001:8001 -p 8002:8002 -v $PWD/docs/examples/model_repository:/models nvcr.io/nvidia/tritonserver:20.03-py3 trtserver --model-repository=/modelsクライアント側の設定

続いてクライアント側です。

yolov3のクライアント例を作っている先人のdocker image[3]を参考にしながら画像描画部分を修正しgRPC経由でリクエストを投げ推論する、ことをやってみたいと思います。docker pull srijithss/tensorrtserver_client:latest docker run -it -v $PWD/:/opt/code srijithss/tensorrtserver_client:latest bashコンテナに入ったら

python trtserver_test.pyが実行できますが、そのままだと表示が見づらいので、inference.pyとして少し修正します。def draw_outputs(self, img, outputs): boxes, objectness, classes, nums = outputs boxes, objectness, classes, nums = boxes[0], objectness[0], classes[0], nums[0] for i in range(nums): x1y1 = tuple((np.array(boxes[i][0:2]) * self.wh).astype(np.int32)) x2y2 = tuple((np.array(boxes[i][2:4]) * self.wh).astype(np.int32)) label = self.class_names[int(classes[i])] class_num = 0 for name in self.class_names: if label == name: class_num = self.class_names.index(name) break cv2.rectangle(img, x1y1, x2y2, self.class_colors[class_num], 2) text = label + " " + ('%.2f' % objectness[i]) tlx = x1y1[0] tly = x1y1[1] cv2.rectangle(img, (tlx, tly - 20), (tlx + 110, tly), self.class_colors[class_num], -1) cv2.putText(img, text, (tlx, tly-5), cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0,0,0), 1) return img def process(self): img = cv2.imread(self.args.img) if self.wh is None: self.wh = np.flip(img.shape[0:2],0) frame_rgb = self.bgr_to_rgb(img, self.args.yolo_size) frames = [] frames.append(frame_rgb) responses = [] yolo_generator = partial(request_generator, self.yolo_request, frames) responses = self.grpc_stub.StreamInfer(yolo_generator()) for response in responses: boxes, scores, classes, nums = process_yolo_response(response) img_out = self.draw_outputs(img, (boxes, scores, classes, nums)) cv2.imwrite('result.jpg', img_out)これでdarknetでおなじみの画像に推論してみると以下のようになります。

python inference.py --img ./dog.jpgこのように、TISにモデルを載せるためにはどのフレームワークで学習しTISがサポートするフレームワークに変換できるかどうか、設定ファイルを正しく記述しているかが重要となります。一回載せてさえしまえば、httpまたはgRPC経由でAPIとして機械学習モデルを利用することができるのは便利だなと思います。

ただし設定ファイルの書き方やクライアント側の書き方もgRPCに慣れていないと難しかったです。src/clients/python/examplesにいくつかサンプルがあるのでこの辺が参考になります。(C++, go もある)おわりに

Triton Inference Server を使って画像認識モデルの推論を試してみました。

ほかのタスク(音声認識など)をデプロイしたり、torchscript 形式での実行やonnxでの実行など検証したいことはほかにもあるので、それらが今後の課題です。

Jetsonシリーズではあまりなさそうですが、GPUクラスタでの実行において今後もServingのフレームワークは重要なポイントになりそうです。参考

- 投稿日:2020-12-01T22:53:36+09:00

PythonでJavaScriptの分割代入のようなことをする

やりたいこと

JavaScriptの分割代入のようなことがPythonでしたいです。

destructuringAssignment.jslet a, b, c; [a, b, c] = ["x", "y", "z"]; console.log(a, b, c); // x y z結論

Pythonのシーケンスのアンパックによって実現できます。

unpack.pya, b, c = ("x", "y", "z") print(a, b, c) # x y z余談

Pythonのテキストデータはテキストシーケンス型であり、シーケンスのアンパックが行えます。

textunpack.pya, b, c = "xyz" print(a, b, c) # x y zこのPythonの挙動を見て、JavaScriptではどうなるのか試したところ。。。

textDestructuringAssignment.jslet a, b, c; [a, b, c] = "xyz"; console.log(a, b, c); // x y zいけました!ただし、色々調べましたがこちらの仕様がECMAScriptのどこで定義されているのかはよくわかりませんでした。。。

さらにここから、見かけ上Pythonと同様の記法も試してみました!

textUnpack.jslet a, b, c; a, b, c = "xyz"; console.log(a, b, c); // undefined undefined xyzどうやら左辺の最後の変数に右辺の値が代入され、左辺の最後以外の変数は

undefinedとなるようです。

このあたりの仕様も一旦この記事にメモ書きして、興味が湧いたらまた調べます!参考URL

分割代入 - JavaScript | MDN

5. データ構造 — Python 3.9.1rc1 ドキュメント

組み込み型 — Python 3.9.1rc1 ドキュメント

- 投稿日:2020-12-01T22:40:47+09:00

内点法の概要と主双対内点法のアルゴリズムの解説

はじめに

凸最適化問題に使われている主双対内点法の解説を目標に、凸最適化の概要を説明します。二次計画がメインターゲットです。

この記事は

- ソルバーは使ったことあるけど、もう少しアルゴリズムの中身が知りたい

- 凸最適を学びたいけど、最適化の章までの道のりが長すぎてつらい

な方が対象です。いまどき1から凸最適アルゴリズム実装しようなんて物好きは稀だと思いますが、この記事の目的は主双対内点法を実装するための知識を全体的にふわっと理解することです。

二次計画でよく使われる 主双対内点法 と 有効制約法 を以下に可視化しました。解の求め方が全く異なることが分かります。コードはpythonです。

主双対内点法(primal dual interpoint)

- 内点法の系譜(有効領域の内部を進む)

- 徐々に相補性残差を減少させて最適解を得る

- 線形計画、二次計画、非線形計画まで幅広く対応可能

- 高次元の問題が得意

有効制約法(active set)

- 単体法の系譜(有効領域の壁に沿って進む)

- 二次計画専用

- 等式制約が成立する拘束条件を探索して最適解を得る

- 拘束条件の数が少ない場合は高速

https://github.com/TakaHoribe/python_algorithm/tree/master/convex_optimization_algorithms

※ 初学者向けの記事ですので、厳密性は欠きます。ご容赦ください。

なぜ凸最適化問題は複雑なのか

凸最適は実用性が高いツールであり、matlabやpythonなどの言語を使えば数行で凸最適を実行できます。そのため「まず使ってみる」から入る人が多数だと思います。

そこから、もう少し複雑な問題が解きたい!と勉強し始めると、双対定理、制約想定、実行可能解、スラック変数、ラグランジアン、などなど知らない単語がたくさん出てきます。アルゴリズムを知るために理解しないといけないことが多すぎます(もちろん重要なのですが)。

凸最適の理論を複雑にしている原因の1つが、「不等式制約」の存在です。

具体的な説明に入る前に、以下の3つケースについて解法をざっと比較してみます。

- 等式制約なし

- 等式制約付き

- 不等式制約付き

※ 簡単のために、この章は関数は全部1次元としてます。式は厳密ではないのでご注意を。

1. 制約なしのケース

まずは 制約なし凸最適化問題 です。

\min \ f(x) \tag{1}この解は勾配が0になる点、つまり $\nabla f(x)=0$ を満たす$x$を探すことによって最適解を得ます。これはただの方程式なので、ニュートン法などを使えば簡単に解けます。

2. 等式制約付きのケース

等式制約付きの問題設定は以下の形。

\min \ f(x),\quad {\rm s.t.}\ \ g(x) = 0. \tag{2}これはラグランジュの未定乗数法 と呼ばれるテクニックを用いて、

\begin{aligned} \nabla f(x)+ \lambda \nabla g(x) &= 0,\\ \ g(x)&=0. \end{aligned}を満たす $x, \lambda$ を計算すれば最適解が求まります。少し式が複雑になりましたが、これも結局ただの連立方程式なので、ニュートン法で解けます。低次元であれば手計算も可能で、大学の定期テストでも出てきます。ちなみに、ラグランジュの未定乗数法は18世紀(一説では1788年)には完成していました。

3. 不等式制約付きのケース

これは最も一般的な最適化の形で、問題設定は以下。

\min \ f(x),\quad {\rm s.t.}\ \ h(x) \leq 0. \tag{3}先の(2)と(3)の違いは等式制約「=」が不等式制約「<=」に変わっただけです。このケースは以下で表されるKKT条件を満たす解を計算することによって求めます。

\begin{aligned} \nabla f(x) + \lambda \nabla g(x) + \mu \nabla h(x)=0,\\[6pt] g(x) = 0,\quad \quad h(x) \leq 0,\\[6pt] \mu \geq 0,\quad \quad \mu h(x) = 0. \end{aligned}一気に式が複雑になりました。まず、このKKT条件は不等式が入っているので、これまで有効だったニュートン法が(直接は)使えません。また、このKKT条件の論文が公開されたのは1951年であり、ラグランジュの未定乗数法の発見から200年近くも経っています。等式を不等式に変えただけで200年かかるのです。このKKT条件の導出には双対などの複雑な概念が取り入れられています。また、凸最適問題のほとんどがこの不等式付きのケースであるため、凸最適化全体が難しく見えてしまっているわけです。

つまり、凸最適化の理論は研究者たち長年かけて作り上げてきたものなので、そりゃ難しいよね、という結論です。

(※無理やり近似して解く方法はもっと前から知られていたらしいですが。)

ですが、目的もよくわからない概念を勉強していたら1日が終わっていた、なんてことは避けたいので、ここからは完璧な理解よりアルゴリズムの実装に重点を置いて凸最適の概要をまとめます。

今はとりあえず、不等式ってそんなめんどくさかったんだ、程度に思っていただければ大丈夫です。

もっと詳しく知りたいなーと思った方は、コチラをどうぞ。

凸最適化とは

凸最適化問題とは、凸空間で凸関数を最小化する問題です。「凸」がここまで注目される理由は、とにかく数学的に扱いやすいからです。

凸関数

定義:関数上の任意の二点を結んだ直線が必ずもとの関数の上に存在する。

特徴:極値が1つしかない

つまり:極小値が必ず最小値になる。凸空間

定義:空間上の任意の二点を結んだ直線が必ずもとの空間の内部に存在する。

特徴:直線で任意の空間上を移動できる。

つまり:直線で移動できない領域は考えなくて良い。これらの特徴のおかげで、勾配方向に直線探索をしながら極小値を求めれば、それが最適解であることが保証されます。

逆に凸関数ではない場合は、たとえ極小値であっても最小値と確定することはできません。

また凸空間ではない場合は、直線探索で境界にぶつかった際に、その境界を回り込んだ裏の空間の存在も考えければなりません。とりあえず定式化と標準形

凸最適化は一般的に凸関数 $f(x),\ h(x)$ を用いて以下の形で書かれます。

\min \ f(x),\ \ {\rm s.t.}\ h(x) \leq 0.ここで、$h(x)\leq 0$ は凸空間を表しています( $h(x)\leq 0$ が凸空間を表す...?ってなった方はこちら)。

これを凸最適の標準形に変形します。

ここで、下のような一次関数を考えます(凸最適ではアフィン関数という名前でよく出てきます)。

g(x)=Ax+bこの一次関数は定義上は凸関数であり、符号を逆転した $-g(x)$ も凸関数であるという特徴があります。これを利用して、

g(x) \leq 0,\ \ -g(x) \leq 0と制約を作ることによって、実質 $g(x)=0$ という等式制約条件を凸最適化の中に入れ込むことができます。

これを利用して、凸最適化問題は凸関数 $f(x)$, $h(x)$ および一次関数 $g(x)$ を用いて以下のように標準化されます。

\begin{aligned} \min \ &f(x),\\ {\rm s.t.}\ \ &g(x) = 0,\\ &h(x) \leq 0. \end{aligned} \tag{4}標準形というよりは、一次関数という特殊ケースに対応した特殊形のように思えるのですが、等式制約というのが非常に有用なので、この形式を標準形として議論を進めることが多いです。

標準形をもっと簡単な形にしたい(スラック変数による変形)

標準形(4)では $h(x)\leq 0$ という不等式制約がありますが、はじめにも述べたとおり、基本的に最適化問題において「不等式」制約は非常に厄介な代物で、「等式」制約のほうが遥かに簡単に取り扱えます。

そこで、なんとかしてこの不等式制約 $h(x)\leq 0$ を等式制約に変形します。このとき使われる変数はスラック変数と呼ばれ、変数 $s$ で表されることが多いです。

スラック変数の効果を確認します。まず、

h(x) \leq 0この不等式は、

h(x)-s=0,\quad s\geq 0と同じ意味であることを確認してください。"スラック" は日本語で "緩み" や "余裕" みたいな意味なので、 不等式を直接扱うのではなく、等式からの "余裕" に対して不等式制約を付けるイメージです。この要領で、最適化問題の標準形は、スラック変数を用いて

\begin{aligned} \min_{x,\ s}\ &f(x),\\ \ {\rm s.t.}\ \ &g(x)=0,\ h(x)-s=0,\\[5pt] & s \geq 0 \end{aligned}と書くことができます。

これの何が嬉しいかと言うと、最適化問題において最も厄介な不等式制約が、$s\geq 0$ という非常に簡単な形で書き下せることです。

ただ、今の状態では変数 $x$ とスラック変数 $s$ の2つが変数として存在し、そのうちスラック変数のみに不等式制約がついています。これではすこし使いづらいので、もう少し工夫をします。変数$x$を

x=x^+-x^-,\ \ x^+\geq 0,\ x^- \geq 0と分解してやると、最適化問題を

\begin{aligned} \min_{x^+,x^-,s}\ &f(x),\\ \ {\rm s.t.}\ \ &g(x)=0,\ h(x)-s=0,\\[5pt] & x^+\geq 0,\ x^- \geq 0,\ s \geq 0 \end{aligned}と書き換えることができます。不等式制約を見ると、最適化変数として使用されている$(x^+,x^-,s)$の全てに対して不等式制約がついています。これをまとめて $x=[x^+,x^-,s]^T$ と再定義して、等式制約もすべてまとめて $g(x)$と定義しなおせば、最終的に最適化問題は

\begin{aligned} \min_{x}\ &f(x),\\ \ {\rm s.t.}\ \ &g(x)=0,\\[5pt] & x \geq 0 \end{aligned} \tag{5}と書くことができます。変数の次元が2倍以上になりましたが、それでも厄介な不等式制約を $x\geq 0$といった単純な形にできるのは大きなメリットがあります。

(4)式、(5)式のどちらも標準形としてよく出てくる形ですが、一般論を議論するときは(4)、アルゴリズムの説明では(5)を用いることが多いです。

凸最適化で用いる用語の説明

凸最適化には双対性など色々と小難しい用語が出てきますが、計算を回すだけであれば、凸性の特徴とKKT条件の形だけ知っていればなんとかなります。

この記事でも、双対みたいな難しい用語はなるべく使いたくないのですが、このあたりの流れを知らないと、凸最適(というより最適化問題)で一番重要なKKT条件が完全にブラックボックス化してしまいます。そして論文やドキュメントの多くでは、これは双対変数の〜と言った書き方をされるので、ある程度用語を知らないと理解が進みません。なので、かなり雑ではありますが、全体の用語のつながりを説明します。(一つ一つの詳細は省きます。)

※ 表記や可解性のような厳密さは無視するのでご容赦ください

忙しい人へ

KKT条件

不等式制約付き最適化問題の最適解が満たすべき必要条件。凸最適化問題ではほとんどのケースで必要十分条件となる。式に出てくる$\lambda$や$\mu$は、導出の仮定で双対問題の変数になったり、ラグランジュ関数の係数になったりするので、双対変数とかラグランジュ乗数とか呼ばれる。双対問題

与えられた問題(主問題)に対応するラグランジュ関数を最大化する問題。この問題自体が重要と言うよりは、双対定理と組み合わせて初めて意味がある。双対定理

KKT条件の元になった定理で、最適解において双対問題と主問題の目的関数が一致するという定理。相補性条件

KKT条件に出てくる式の一つで、解釈が重要なので名前がついている。最適解においては、不等式制約の関数か、そのラグランジュ乗数のどちらかが0である、という式。双対ギャップ

主問題と双対問題の目的関数の差。双対定理から、最適解であれば差は0であるため、どれだけ最適解から離れているかの指標として使われる。これらの単語の関係性をまとめたものが下図。以下はこの図をベースに説明します。

1次最適性条件

図の左側で四角く囲まれている部分です。ここだけ先にまとめてバッと説明します。

1次最適性条件とは、最適解において1階導関数が満たすべき必要条件です。「制約なし」最適化問題では

\nabla f(x)=0となり、見慣れた形になります。

ちなみに、2次最適性条件というのもあり、制約なし最適化問題の2次最適性条件は $\nabla^2 f(x)>0$ となります。凸関数は定義から常に2次最適性条件を満たすため、凸最適に限っては特に意識しません。

ラグランジュの未定乗数法

「 "等式" 制約付き最適化問題における1次の最適性条件」を導出する方法がラグランジュの未定乗数法であり、以下の式で表されます。

\begin{aligned} \nabla f(x) + \sum_i \lambda_i \nabla g_i(x) =0,\quad g(x) = 0 \end{aligned}これは大学で習った人も多いと思います。ラグランジュ未定乗数法から得られる以下の式:

-\nabla f(x)=\sum_i \lambda_i\nabla g_i(x)これは「(左辺)コストを下げる方向が(右辺)制約条件の法線方向と同じ向きである」ということを意味しています。逆に向きが同じでない場合は、「制約を満たしながら移動可能な方向にコストを下げる方向成分がある」ことを意味し、その点は最適解ではないことになります。以下はよく出てくる幾何的解釈の図。

KKT条件

「"不等式" 制約付き最適化問題における1次の最適性条件」を KKT条件(Karush-Kuhn-Tucker condition) と言い、以下で表されます。

\begin{aligned} \nabla f(x) + \sum_i \lambda_i \nabla g_i(x) + \sum_i \mu_i \nabla h_i(x)=0,\\[6pt] g(x) = 0,\quad \quad h(x) \leq 0,\\[6pt] \mu \geq 0,\quad \quad \mu_i h_i(x) = 0. \end{aligned}式の形はラグランジュの未定乗数法に似ていますが、その他にも条件がいくつか追加されています。また、このKKT条件は常に成り立つわけではないのですが、問題が凸であればほとんどのケースで成立するので、特に考えなくてokです(制約想定について)。

KKT条件の1つ目の式:

-\nabla f(x)=\sum_i \lambda_i\nabla g_i(x) + \sum_i \mu_i \nabla h_i(x)これもラグランジュの未定乗数法と同じように幾何的な解釈が可能です。厄介なのが不等式制約の $h(x)$ なのですが、これはKKT条件の5番目の式(相補性条件):

\mu_i h(x)_i=0から、$h(x)\neq 0$ (制約が非アクティブ) のときは $\mu=0$ であるため、実際に勾配を考えるのは $h(x)= 0$ の場合だけとなります。なので結局ラグランジュの未定乗数法とイメージは同じになります。

KKT条件の導出仮定(凸最適問題の流れ)

ここからKKT条件の導出仮定を大雑把にまとめます。上の図で番号を降ったので、その順番で解説していきます。

①主問題

解きたい凸最適化問題です。後に示す双対問題と比較して、主問題と呼ばれます(Pは主:Primalの意味)。

(P)\ \ \min \ f(x),\ \ {\rm s.t.}\ \ g(x)=0,\ h(x) \leq 0.②ラグランジュ関数

主問題が与えられましたが、いきなりこれを解くのは大変です。とりあえず制約条件が厄介なので、目的関数 $f(x)$ と制約条件 $g(x)$, $h(x)$ に重みを付けて足し合わせたら、何か分からないかな?なノリで、与えられた主問題に対して、ラグランジュ変数と呼ばれる変数 $\lambda,\ \mu$ を導入してラグランジュ関数を作ります。

L(x, \lambda, \mu) = f(x)+\sum_{i=1}^m\lambda_ig_i(x)+\sum_{i=1}^l\mu_ih_i(x)難しいことはしていません。ただそれぞれの関数に変数を掛けて足しただけです。

③ラグランジュ双対関数

②で作ったラグランジュ関数は、凸関数の和なので凸関数になります。拘束条件がないので最小化しやすそうです。なのでとりあえず最小化しましょう。

ラグランジュ関数に対して、$x$ で最小化したものをラグランジュ双対関数といいます。q(\lambda, \mu) = \inf_x \ L(x, \lambda, \mu)ここでもまだ難しいことはしていません。ただ最小化した値を$q$と定義しただけです。

このラグランジュ双対関数の値$q$と主問題の目的関数 $f(x)$の値を比較することによって、次の弱双対定理が得られます。

④弱双対定理

弱双対定理は 「$\mu\geq 0$のとき、ラグランジュ双対関数の値 $q(\lambda, \mu)$ は、主問題の目的関数の値 $f(x)$ を超えない」 というものです。数式で書くと、こう。

\forall \lambda \in \mathbb{R}^m,\ \forall \mu \in \mathbb{R}^l_{+},\ \ \ f(x)\geq q(\lambda, \mu)これは簡単に証明ができます。(制約条件から $g(x)=0,\ \mu h(x)\leq 0$ であることを考えれば、すぐ導出できます。)

この定理の何が嬉しいのかというと、不等式制約のせいで解くのが難しい主問題に対して、制約条件を取り除いたラグランジュ双対関数を最適化すれば、少なくとも主問題の下界が計算できるようになります(下界:最小値以下のなんらかの値)。ラグランジュ双対関数の最適化問題は制約なし凸最適化のため、非常に簡単に実行可能です。

しかし、あくまで求まるのは下界であり、下界が10だとしても、実際の最小値は100かも1000かもしれません。

ちなみに、この下界と、実際の最小値の差 $f(x)- q(\lambda, \mu)$ を双対ギャップと呼びます。

こうなると、この下界をどこまで実際の最小値に近づけることができるのか(ラグランジュ双対関数の値はどこまで大きくできるのか?)という問題を考えたくなります。これが双対問題です。

⑤双対問題

ラグランジュ双対関数は変数として $\lambda$ と $\mu$ を持っています。なので、この変数を変化させれば、より正確に下界を見積もることができるはずです。このように、ラグランジュ双対関数の最大値を求める問題を双対問題といいます。

この問題のニーズは上の弱双対定理から来ているので、弱双対定理の前提である $\mu \geq 0$ が制約条件に入っています(Dは双対:Dualの意味)。

(D) \ \ \max \ q(\lambda, \mu),\ \ {\rm s.t.}\ \ \mu \geq 0.⑥強双対定理

主問題の最適解を $x^{\ast}$ 、双対問題の最適解を $\lambda^{\ast}, \mu^{\ast}$ とします。

強双対定理とは 「主問題の最小値 $f(x^{\ast})$ と双対問題の最大値 $q(\lambda^{\ast}, \mu^{\ast})$ は一致する」 というものです。つまり、弱双対定理のときに考えた「この下界をどこまで実際の最小値に近づけることができるのか」に対する答えは、「完全に一致できる」となります。

f(x^{\ast}) = q(\lambda^{\ast}, \mu^{\ast})主問題と双対関数の目的関数の差は双対ギャップと呼ばれるので、強双対定理は 「最適解では双対ギャップは0である」 と言い換えることもできます。

今まで何となくラグランジュ関数を作って、ゴニョゴニョしてきたのも、全てはこの強双対定理を導くためです。感覚的には、こいつがラスボスです。

この定理の何がすごいかというと、

- 双対問題を解けば、主問題の最適値も求まる

- 双対ギャップを計算するだけで、その解が最適かどうか分かる

という点です。

そもそも不等式制約がついた最適化問題は解析が難しいので、この定理が無いと、最適解かどうかを見極めるだけで一苦労です。それがこの定理のおかげで(双対問題という謎の問題を1つ余分に解かなくてはいけませんが)2つの目的関数の差を計算するだけで最適解かどうかを判定することができます。

このように、今まで何となくラグランジュ関数やら双対問題やらを定義してきましたが、この定理でそれら全てが関連付けられます。

なお、この定理は常に成り立つわけではなく、主問題が制約想定(constraint qualification)と呼ばれる条件を満たしている必要が有ります。強双対定理を使うときは、主問題がこの制約想定が満たされているか確認する必要があるのですが、凸最適化問題の場合は大抵のケースで満たされているため、ここでは深く言及しません。

⑦KKT条件

強双対定理をベースに、主問題の1次最適性条件を書き出したのがKKT条件です。

\begin{aligned} \nabla f(x) + \sum_{i=1}^m \lambda_i \nabla g_i(x) + \sum_{i=1}^l \mu_i \nabla h_i(x)=0,\\ g(x) = 0,\\ h(x) \leq 0,\\ \mu_i \geq 0,\\ \mu_i h_i(x) = 0. \end{aligned} \tag{6}2~4本目の式は、主問題と双対問題の拘束条件から持ってきたもので、1と5本目の式は強双対定理を解析すると出てきます。

基本的にすべてのアルゴリズムは、この条件を満たす解を求めるのが目標なので、最低限このKKT条件の式の形だけ知っていればなんとかなります。

⑦-2 相補性条件

KKT条件の中で5本目の式は特に解釈が重要で、 「相補性条件」 と名前がついています。これは不等式制約の関数 $h(x)$ もしくは、その制約に対応する双対変数 $\mu$ のどちらかが0でなければならない、ということを意味しており、有効制約法の有効制約の判定などに用いられます。

後ほど説明する主双対内点法では、この相補性の右辺を大きな値から徐々に0に近づけて行くことによって最適解を見つけます。

アルゴリズム

用語の説明が終わったところで、実際の最適化アルゴリズムの説明に入ります。

主双対内点法の説明がメインですが、すべての内点法は「実行可能領域の内部で解を徐々に変化させて最適解を求める」という方針のため、極論その解の変化方向と変化量をどう決めるかという問題に帰着します。その違いを確認するためにも、ここでは 主内点法 の一種であるバリア法と、主双対内点法 の一種であるパス追従法について説明します。

バリア関数法(主内点法)

バリア関数法のほうが理解しやすいため、先に説明してしまいます。

バリア法は内点法の一種で、不等式制約をlog関数で近似して、ニュートン法でゴリ押しで解く方法です。非常に直感的で、ここに双対とかラグランジュといったワードは出てきません。(現在は主双対内点法が主流なのであまり使われていないようです。)

ここではまず、凸最適化問題の標準形(5)

\min_x f(x),\quad {\rm s.t.}\ g(x)=0,\ \ x \geq 0を、以下の形

\min_x f(x) - \nu \sum_{i=1}^l\log (x_i),\quad {\rm s.t.}\ g(x)=0.に近似します。等価な変形でないことに注意してください。変化点は、不等式制約が消えたことと、目的関数に以下の関数が追加されたこと。

- \nu \sum_{i=1}^l\log (x_i)これはバリア関数と呼ばれ、$x_i$ が正の方向から0に近づくに従って無限大に発散する関数で、$x_i\geq 0$ の制約の代わりとして近似的に使うことができます。

下の図がバリア関数ですが、$\nu$ が小さくなるに従って、壁が急になり、かつ $x>0$ の部分の値はほぼ$0$であることが分かります。 なので、 $\nu$ が小さい値であれば、殆どの領域でコスト関数に影響を及ぼさず、かつ $x>0$ の制約を取り込むことが可能です。

この時点で、問題から不等式制約が消えているので、ニュートン法を適用したら解くことができます。そして $\nu$ が十分小さい値であれば近似精度も良いはずです。ただし、問題が1つ。急すぎるバリア関数は $x=0$ に近づくと勾配がほぼ無限大になってしまうため、ニュートン法のような微分を使う計算がうまく回りません。

そこで、とりあえず大きな $\nu$ の値をとって、ニュートン法で解きます。その解を初期点として、$\nu$ を少し小さくした問題に対して、またニュートン法で解きます。このように徐々に $\nu$ を小さくして行きながら、本当の解に近づけていきます。こうすると、たとえ勾配が非常に大きな値でも、目標点が初期値のすぐ近くにあるため、計算が発散することはありません。

双対のような概念も現れず、直感的に分かりやすい方法ですが、バリアパラメータ $\nu$ のイテレーションとニュートン法のイテレーションの2種類の反復計算が行われるため、あまり効率の良い方法ではありません。

主双対内点法

主双対内点法は、主問題と双対問題をまとめて解くことによって、主問題の最適解を求める方法の総称です。

そもそも、本来求めたい解を得るためには双対問題は不要であり、無駄に次元を増やしているだけに感じますが、KKT条件を使って主問題と双対問題をまとめて解いたほうが高速と言うことが知られてから頻繁に使われるようになりました。なぜ主双対内点法が高速なのかについて(個人的な)考察は後ほど。

先程で述べた主内点法では $x_{k+1}=x_k+dx_k$ のように徐々に主問題の変数 $x$ を変化させて最適値を探しました。

一方で主双対内点法は、主問題の変数 $x$ と双対問題の変数 $\lambda,\ \mu$ の3変数を同時に変化させて最適値を探す方法です。\begin{aligned} x_{k+1}&=x_k+dx_k\\ \lambda_{k+1}&=\lambda_k+d\lambda_k\\ \mu_{k+1}&=\mu_k+d\mu_k \end{aligned}特徴としては、

- 変数、拘束条件の次元が大きい場合に有利

- 非線形最適化にも適用可能

が挙げられます。

主双対内点法にも勾配計算の違いによって、アフィンスケーリング法、パス追従法、ポテンシャル法などの種類がありますが、基本方針はどれも 「KKT条件を満たす解をニュートン法で求める」 です。

1つ理解してしまえば後は似た感じです。ここではイメージしやすい パス追従法 を取り上げて説明します。

例として、二次計画問題で確認してみます。二次計画問題の標準形は以下のようになります。

\min \ \frac{1}{2}x^TQx+c^Tx,\quad Ax=b,\ x\geq 0.この問題に対するKKT条件(6)は

\begin{aligned} &Ax = b,\ \ x \geq 0,\\ &A^T \lambda+ \mu=Qx+c,\ \ \mu \geq 0,\\ &x_i \mu_i=0 \end{aligned}となります。この式が $(x, \lambda, \mu)$ について解ければ万事解決なのですが、厄介な箇所が二点。

- $x\geq 0,\ \mu \geq 0$ の不等式制約の存在

- 相補性条件が非線形項 $x_i \mu_i$ を含む

この2点がクリアされれば、このKKT条件はただの線形連立方程式になるので解析的に解くことができます。

まず、1点目の不等式制約はとりあえず無視します(あとで対応する)。2点目の双線形は、適当な解の近傍で線形近似する、といった方針で進めます。

まずは不等式制約を無視しましょう。また、相補性条件 $x_i\mu_i$ も添字 $i$ がややこしいので、行列 $X$ を導入してベクトルで形式記述しておきます。 すると、解きたい方程式はこうなります。

\begin{aligned} &Ax = b,\\ &A^T \lambda+ \mu=Qx+c,\\ &X \mu=0.\\[6pt] & {\rm where}\ \ X={\rm diag}(x_1, \cdots, x_n) \end{aligned} \tag{7}次に線形近似について考えます。KKT条件の変数 $(x, \lambda, \mu)$ に対して、適当に初期値 $(x_0, \lambda_0, \mu_0)$ を取ってやります。ちなみにこの初期値は $e$ を単位ベクトルとして $x_0=10^5e,\ \lambda=0,\ \mu_0=10^5e$ のような値を選ぶことが多いそうです。

このとき、初期値 $(x_0, \lambda_0, \mu_0)$ を、

\begin{aligned} x_{k+1} \leftarrow x_k + dx\\ \lambda_{k+1} \leftarrow \lambda_k + d\lambda \\ \mu_{k+1} \leftarrow \mu_k + d\mu \end{aligned} \tag{8}と動かして(7)式を満たす解を求めることを考えます。記述が面倒なので、変数 $z=(x, \lambda, \mu)$ を導入して、この式を下のように書いておきます。

z_{k+1}\leftarrow z_k+dz移動後の解 $z_k+dz$ には方程式(7)を満たしていてほしいので、$z=z_k+dz$ を(7)に代入すると、

\begin{aligned} &A(x_k+dx) = b,\\ &A^T( \lambda+d \lambda)+( \mu_k+d \mu)=Q(x_k+dx)+c,\\ &(X_k+dX)( \mu_k+d \mu)=0 \end{aligned} \tag{9}となります。ここで$dz$が微小であるとして2次の変分量 $dXd\mu \simeq0$ と線形近似を施してやります。すると、(9)の3本目の相補性条件の式は

\begin{aligned} &(X_k+dX)( \mu_k+d \mu) \\[6pt] & \simeq X_{k} \mu_{k} + X_{k}d \mu + \mu_{k}dX = 0 \end{aligned}と近似されます。ここまでをまとめると、解くべき式は

\begin{aligned} &A(x_k+dx) = b,\\ &A^T( \lambda+d \lambda)+( \mu_k+d \mu)=Q(x_k+dx)+c,\\ &X_{k} \mu_{k} + X_{k}d \mu + \mu_{k}dX = 0 \end{aligned}となります。ここまででやっているのは、線形近似して変化量を求めるという、通常のニュートン法の考え方です。正直これをいきなり解いても良いのですが、この式をいきなり $dz$ について解くと、目的値が適当に取った初期値から離れすぎてしまい、線形近似で用いた $dz$ が微小という仮定が破綻してします。そのためパス追従法では「現在の相補性条件の左辺値 $(x_i\mu_i)$ を大きく変化させない範囲で $z$ を動かす」という方針を取ります。

今の解 $z_k$ におけるの $X_i\mu_i$ の平均値 $\nu_k$ を計算しましょう。(とりあえずここでは 相補性残差 と呼びます)

\nu_k= \frac{1}{N}\sum_i^N \left( x_i\mu_i \right)_kこの現在の相補性残差に近い値として、スケールを掛けた相補性残差 $\sigma \nu_k,\ \sigma \in [0, 1)$ を用いて計算を行います。なので結局、KKT条件はこんな感じで近似されます。

\begin{aligned} &A(x_k+dx) = b,\\ &A^T( \lambda+d \lambda)+( \mu_k+d \mu)=Q(x_k+dx)+c,\\ &X_{k} \mu_{k} + X_{k}d \mu + \mu_{k}dX=\sigma \nu_k \end{aligned} \tag{10}これを行列形式で書いたものがこちら。

\begin{aligned} &\begin{bmatrix} A & 0 & 0 \\ -Q & A^T & I\\ M_k & 0 & X_k \end{bmatrix} \begin{bmatrix} dx \\ d \lambda \\ d \mu \end{bmatrix} = \begin{bmatrix} b-Ax_k \\ Qx_k+c-A^T \lambda_k- \mu_k\\ \sigma\nu_k e - X_k \mu_k \end{bmatrix},\\[9pt] &X_k={\rm diag}(x_{k1}, \cdots, x_{kn}),\\ &M_k={\rm diag}(\mu_{k1},\cdots,\mu_{kl}),\quad e=[1,\cdots,1]^T. \end{aligned} \tag{11}この式の左辺はKKT行列などとも呼ばれます。この式はただの $(dx, d\lambda, d\mu)$ の一次連立方程式なので、数値計算で容易に解けます。この解 $dz$ をもとに本来求めたい解 $z$ を更新していきます。(実用上 $\sigma$ は0.1や0.01といった値が用いられるそうです。)

この更新のタイミングで、一番最初に無視した不等式条件を考慮します。

ここで、式(8)から求めた変化量を $dz_k$としましょう。このときの解の更新における方針は、スカラ係数 $\alpha$ を使って、不等式制約を壊さないように $\alpha$ の値を調節しながら、

z_{k+1} \leftarrow z_k + \alpha dz_kのように解の値を更新するというものです。そして、これは簡単な計算から、 $\alpha$ が以下の式を満たしていれば、更新によって不等式制約 $x\geq0,\ \mu\geq 0$ が破られることがないことが分かります。

\alpha = \min \left\{ \min_{dx_i<0} \left(-\frac{x_i}{dx_i}\right),\ \min_{d\mu_i<0} \left( -\frac{\mu_i}{d\mu_i}\right) ,1\right\}この更新によって求められた解を新たな初期値として、(11)式を解いて徐々に双対ギャップを下げていき、ある一定値以下になったところで計算をストップし、最適解を得ます。

解の収束性などの議論はすっ飛ばしましたが、これが大まかな主双対内点法の概要になります。

線形計画、二次計画に適用した場合は以下のような方針になります。

参考記事:

- 内点法 - wikipedia

- 主双対内点法 - 線形計画におけるパス追跡法

- 2次計画問題と内点法 - 東京工業大学 講義資料

- Primal-Dual Interior-Point Methods - CMU Lecture Notes

実装例:IPOPT

バリア法と主双対内点法の共通点(なぜ主双対内点法は高速なのか)

ここを読むと、主双対内点法がなぜ高速計算可能なのかのイメージが(少し)湧きます。(若干発展的な話なので読まなくても良いです。)

バリア関数法を二次計画問題に適用します。二次計画の標準形はこの形。

\min \ \frac{1}{2}x^TQx+c^Tx,\ \ {\rm s.t.}\ \ Ax=b,\ \ x \geq 0.これに対してバリア関数の近似を入れたのが、こんな形。

\min \ \frac{1}{2}x^TQx+c^Tx - \sum_{i}\nu_i \log(x_i) \,\ \ {\rm s.t.}\ \ Ax=b.この式は等式制約条件つきの最適化問題なので、ラグランジュの未定乗数法が適用できます。すると、以下の式が得られます。