- 投稿日:2020-11-25T23:47:26+09:00

【保存版】Flaskで画像を操作したいと思ったときの6パターンについて書き分ける

Flask上で画像を操作する場合、ソースコードのパターンとして画像の生成元をどうするかというもので3パターン、画像の最終的な処理方法をどうするかというもので2パターンで組み合わせで合計6パターンがあると思います。この6パターンについてソースコードを書き分ける必要がありますのでそれについて記載します。

画像の生成元の3つとは

- HTMLからFlaskで立てたURLへ直接画像がアップロードされる場合、

- Flaskの関数の中でmatplotlibなどで生成する場合、

- クラウドないしはローカルフォルダなどに保存されている画像を読み込んでくる場合

の3つです。

最終的な処理方法として2つあるというのは、

- 画像をクラウドないしはローカルフォルダなどに保存する場合と

- クライアント側へ画像をreturnする場合

の2つです。画像から例えばOCRで情報を抽出して文字列で返す場合もあると思いますが、これはJSONなどでリターンすればOKなので6パターンに中で対応できると思います。

したがって、Flaskで画像を操作したいと思うと、この6パターンについてソースコードを書き分ける必要があり、かなり大変です。

しかし、幸いなことに、この6パターンのうち画像をどこかに保存する場合とクライアント側へ返す場合については、画像をメモリ上でBlob形式で保持することができれば同時に対応できますので、事実上かき分けなければならないのは3パターンとなります。この3パターンについてサンプルのソースコードを整理したいと思います。ここでは、画像の保存先としてGoogle Cloud Storageを利用した例で説明します。適宜AWSのS3、ローカルのフォルダの場所などと読み替えて下さい。今回記載するサンプルコードは下記の3つです。

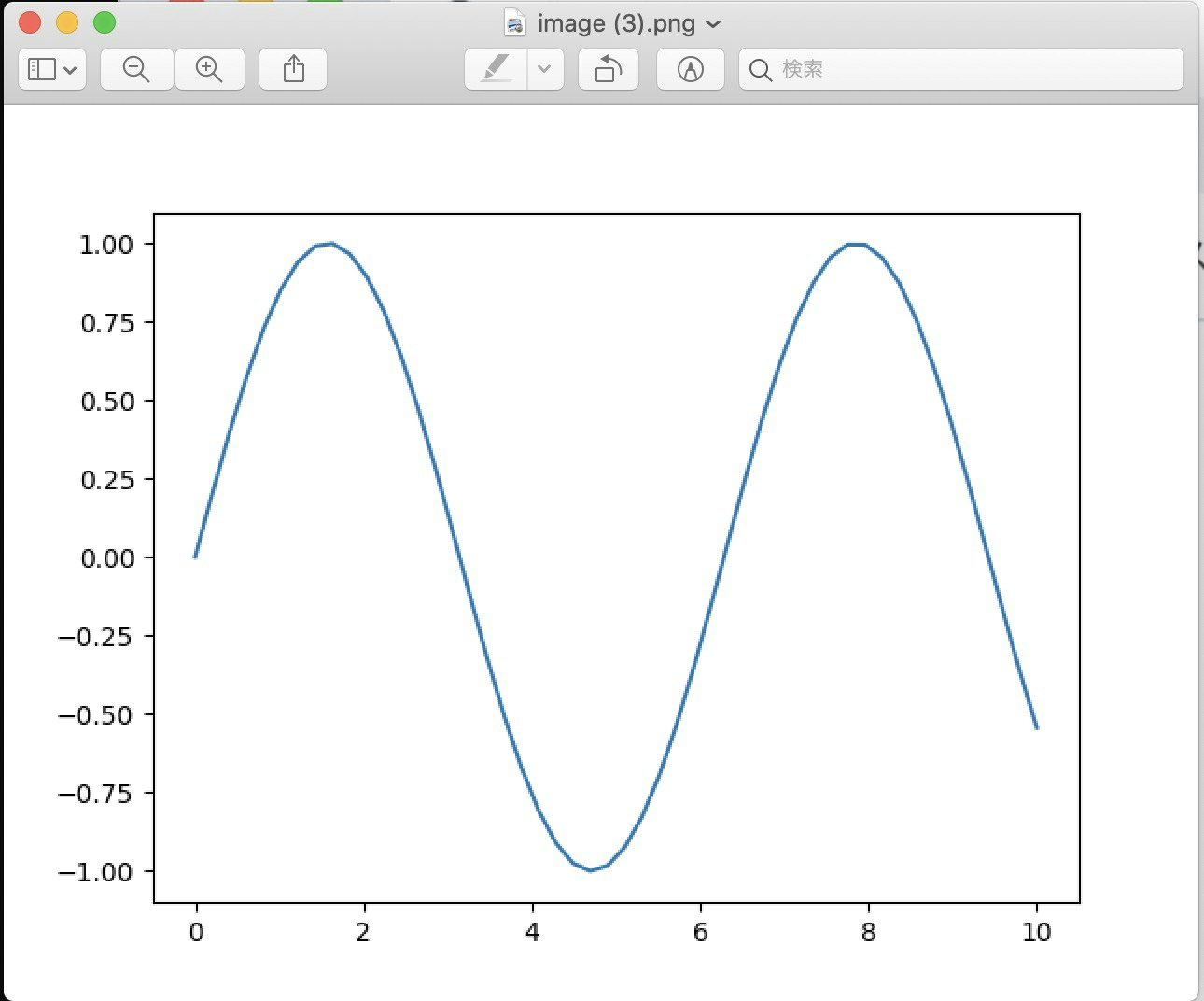

1. 画像をFlaskの関数内で生成し、メモリ上でBlob形式で保持したのちにGCSへ保存しクラウアント側へ返す

2. 画像をクラウアントから受け取り、メモリ上でBlob形式で保持したのちにGCSへ保存しクラウアント側へ返す

3. 画像をGSCから読み取り、メモリ上でBlob形式で保持したのちにGCSへ保存しクラウアント側へ返す画像をFlaskの関数内で生成し、メモリ上でBlob形式で保持したのちにGCSへ保存とクラウアント側へ返す

main.py# -*- coding: utf-8 -*- import io import numpy as np import matplotlib import matplotlib.pyplot as plt matplotlib.use('Agg') from flask import Flask, send_file app = Flask(__name__) @app.route('/') def hello(): buf = io.BytesIO() x = np.linspace(0, 10) y = np.sin(x) plt.plot(x, y) plt.savefig(buf, format='png') buf.seek(0) os.environ['GOOGLE_APPLICATION_CREDENTIALS'] = './path/to/your/credential_goole.json' storage_client = storage.Client() bucket = storage_client.get_bucket('your_backetname.com') blob = Blob(filename, bucket) blob.upload_from_string(data=buf.getvalue(), content_type=content_type) return send_file( buf,attachment_filename=filename,as_attachment=True ) if __name__ == "__main__": app.run(debug=True)ポイントは2つあって、一つはmatplotlib.use('Agg')という部分でGUIに対応していないFlaskで動作するようにしていることと、二つ目はsavefigの部分でメモリ上でファイルを書き出していることです。ローカルで動かす場合は、普通にHDD(SSD?)にjpgなどで書き出しても問題ないと思いますが、クラウドなどだとローカルへのアクセスが禁止されていることが往々にしてあります。この場合に備えて、メモリ上でファイルの読み書きを行うioモジュールを使って、ローカルに書き出すことなく画像を出力します。

画像をGSCから読み取り、メモリ上でBlob形式で保持したのちにGCSへ保存とクラウアント側へ返す

次はクラウドからデータを持ってくる場合です。

main.py# coding: utf-8 import os import io import time import string import random import datetime import numpy as np from PIL import Image import cv2 from flask import Flask, render_template, request, redirect, url_for, send_from_directory,send_file from google.cloud import storage from google.cloud.storage import Blob import inspect import numpy as np import cv2 app = Flask(__name__) @app.route("/", methods=["GET", "POST"]) def hello(): os.environ['GOOGLE_APPLICATION_CREDENTIALS'] = './path/to/your/credential_goole.json' storage_client = storage.Client() bucket = storage_client.get_bucket('your_backetname.com') source_blob_name = "path/to/your/file_on_gcs.jpg" #検索する場合はここを使う """ blobs = bucket.list_blobs(prefix="") for blob in blobs: print(blob.name) print(dir(blob)) print(blob.content_type) source_blob_name = blob.name content_type = blob.content_type print(inspect.getfullargspec(bucket.list_blobs)) """ blob = bucket.get_blob(source_blob_name) buf = io.BytesIO() blob.download_to_file(buf) buf.seek(0) destination_blob_name = "path/to/your/file_on_gcs.jpg" blob = Blob(destination_blob_name, bucket) blob.upload_from_string(data=buf.getvalue(), content_type=content_type) return send_file( buf,attachment_filename=source_blob_name,as_attachment=True ) if __name__ == "__main__": app.run()上記ファイルを実行しFlaskサーバが立てたあと、こちらについてはブラウザなどで直接叩いたいただければ問題ありません。

画像をクラウアントから受け取り、メモリ上でBlob形式で保持したのちにGCSへ保存とクラウアント側へ返す

最後のパターンです。

main.py# coding: utf-8 import os import io import time import string import random import datetime import numpy as np from PIL import Image import cv2 from flask import Flask, render_template, request, redirect, url_for, send_from_directory,send_file from google.cloud import storage from google.cloud.storage import Blob import inspect import numpy as np import cv2 app = Flask(__name__) @app.route("/", methods=["GET", "POST"]) def hello(): if request.files['image']: filename = request.files['image'].filename content_type = request.files['image'].content_type # 画像として読み込み stream = request.files['image'].stream img_array = np.asarray(bytearray(stream.read()), dtype=np.uint8) img = cv2.imdecode(img_array, 1) is_success, buffer = cv2.imencode(".jpg", img) buf = io.BytesIO(buffer) #buf = io.BytesIO() buf.seek(0) os.environ['GOOGLE_APPLICATION_CREDENTIALS'] = './path/to/your/credential_goole.json' storage_client = storage.Client() bucket = storage_client.get_bucket('your_backetname.com') blob = Blob(filename, bucket) blob.upload_from_string(data=buf.getvalue(), content_type=content_type) return send_file( buf,attachment_filename=filename,as_attachment=True ) if __name__ == "__main__": app.run()上記ファイルを実行しFlaskサーバが立てたあと、こちらについては画像をHTMLからアップロードする必要があります。

APIを叩いてcanvas要素に描写するHTMLも載せておきますので、こちらを参考にしてください。buf変数に読み込んだものをOpenCVなどで操作すれば簡単な画像処理ソフトになると思います。index.html<!doctype html> <html lang="ja"> <head> <!-- Required meta tags --> <meta charset="utf-8"> <meta name="viewport" content="width=device-width, initial-scale=1, shrink-to-fit=no"> <!-- Bootstrap CSS --> <link rel="stylesheet" href="https://stackpath.bootstrapcdn.com/bootstrap/4.3.1/css/bootstrap.min.css" integrity="sha384-ggOyR0iXCbMQv3Xipma34MD+dH/1fQ784/j6cY/iJTQUOhcWr7x9JvoRxT2MZw1T" crossorigin="anonymous"> <script src="https://code.jquery.com/jquery-3.3.1.min.js" crossorigin="anonymous"></script> <script src="https://cdnjs.cloudflare.com/ajax/libs/popper.js/1.14.7/umd/popper.min.js" integrity="sha384-UO2eT0CpHqdSJQ6hJty5KVphtPhzWj9WO1clHTMGa3JDZwrnQq4sF86dIHNDz0W1" crossorigin="anonymous"></script> <script src="https://stackpath.bootstrapcdn.com/bootstrap/4.3.1/js/bootstrap.min.js" integrity="sha384-JjSmVgyd0p3pXB1rRibZUAYoIIy6OrQ6VrjIEaFf/nJGzIxFDsf4x0xIM+B07jRM" crossorigin="anonymous"></script> <title>bootstrapとjquery</title> </head> <body> <main> <article> <section> <input type="button" value="Start" onclick="main();"/> <canvas style="height: 30vw;width:50vh"></canvas> </section> </article> </main> <script language="javascript" type="text/javascript"> function main(){ var canvas = document.getElementsByTagName('canvas'); var ctx = canvas[0].getContext('2d'); var img = new Image(); img.src = 'http://0.0.0.0:5000';//FlaskでホスティングしたURL img.onload = function() { img.style.display = 'none'; // ようわからん console.log('WxH: ' + img.width + 'x' + img.height) ctx.drawImage(img, 0, 0); var imageData = ctx.getImageData(0, 0, img.width*2, img.height*2) for(x = 0 ; x < 1000 ; x += 10) { for(y = 0 ; y < 1000 ; y += 10) { ctx.putImageData(imageData, x, y); } } }; } </script> </body> </html>curlコマンドでForm送信は代替できます。

HTML側はcurlコマンドで代替する方法はこちらFlaskで画像を処理場合のソースコードはパターンごとに書き分ける必要があり、普段は目の前のタスクを終わらせて終わりがちですが、今回は6つのパターンについてまとめました。AWSのS3を使う場合やローカルで完結させる場合も同様に処理できると思いますので、ぜひ参考にしていただけるとうれしいです。

この記事が役に立ったと思ったらLGTMお願いいたします

- 投稿日:2020-11-25T23:07:34+09:00

DPさん、お手柔らかに

こんばんは(;´・ω・)

前回、ここ で最後に DP に触れてみましたが、

今一 ピンと来なかったので、もうちょっとカジってみます(*´з`)9初心者なので、早速ググってみると

"分からない"、

"壁"、

"登竜門"

とか色々、一緒に出てきました。

やっぱり皆、一度はハマるんですね。取りあえず、やってみましょう。

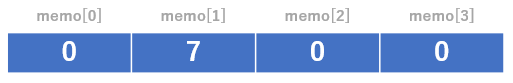

初級問題:与えられた要素を任意に組み合わせて最大値を求めてみます。Combination_DP.pyN = 3 # 要素数 A = [7,-6,9] #要素 memo = [0]*(N+1) # 要素数 + 1 のメモを 1 行(all 0)を用意 for i in range(N): memo[i+1]=max(memo[i],memo[i]+A[i]) print(memo[N])#回答の表示for 文は何をしているのでしょうか?

一個ずつ追って見ましょう。i = 0 のとき

memo[0] には 0 が格納されていますが、

memo[0] + A[0] = 0 + 7 と比べると何方が大きいでしょうか?

勿論、後者ですよね。

計算結果は memo[1] に 7 を格納します。

i = 1 のとき

memo[1] にある 7 と

memo[1]+A[1] の 1 とでは、どちらが大きいでしょうか?

前者ですよね?

この結果は memo[2] に格納します。

i = 2 のとき

memo[2] にある 7 と

memo[2] + A[2] の 16 はどちらが大きいですか?

はい、結果を格納します。

最後に memo[3] を表示すれば回答にたどり着けます。

御覧の通り、計算結果を次のセルに渡すので、最終的には

計算したい要素数 + 1 のメモが必要です。

個人的には、以下のような書き方もあると思います。Combination_DP.pyN = 3 A = [7,-6,9] memo = [0]*(N) memo[0] = A[0] for i in range(1,N,1): memo[i]=max(memo[i-1],memo[i-1]+A[i]) print(memo[N-1])上記は memo[0] に初期値を入れて、

for 文をmemo[1]から始めています。

こうすることで、ひとつ前の値(= i-1)を参考に、

今の値(= i ) を算出することが出来ます。へー( ゚Д゚)

っとなったところでググって次なる問題を探した所、

こちらに出会いました。

分かり易くて感謝のコメントを思わず捧げてしまいました。早速、カエル問題にチャレンジしました。

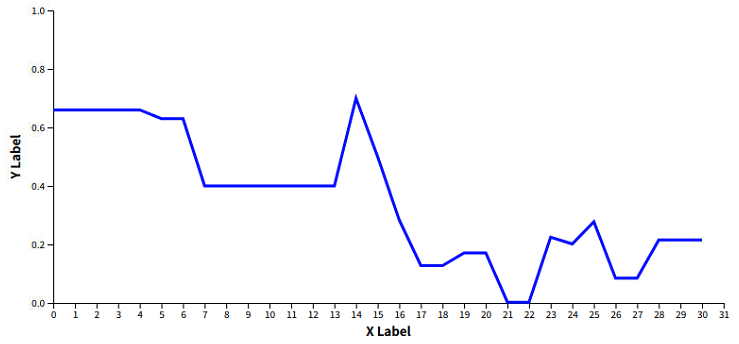

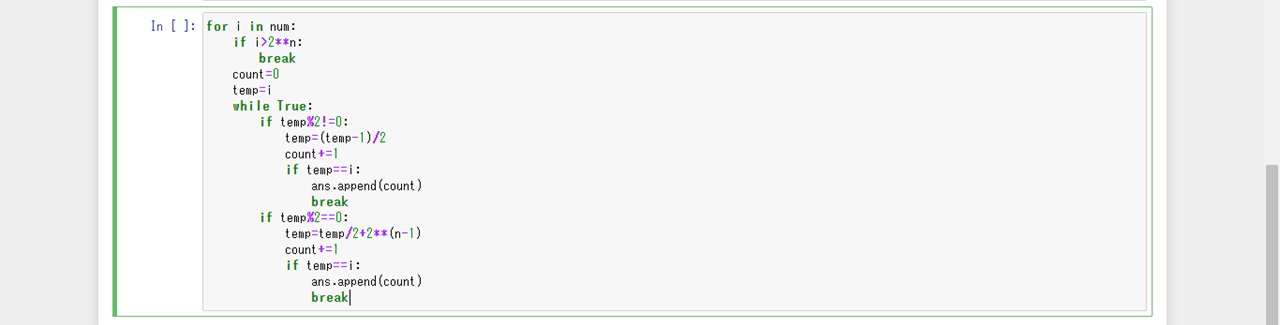

min_cost.pya = [2,9,4,5,1,6,10] N = len(a) memo = [0]*(N) for i in range(1,N,1): memo[i]=memo[i-1]+abs(a[i-1]-a[i]) if i > 1 : memo[i] = min(memo[i],memo[i-2]+abs(a[i-2]-a[i])) print(memo[N-1])有識者の皆様は初期化する意味で、INF を全セルに代入し、

+1 で移動するときのコストと比較して小さい方を上書き。

そのあとに +2 で移動するときのコストを比較して、

小さければ上書きし最終セルを出力されています。個人的には、All 0 初期値とし、

+1 のコストをいきなり上書きしても問題ないと思います。

なぜなら、最初に必ず+1 で移動した場合のコストを埋めてから、

+2 の移動コストと比較しないと問題が解けないからです(笑)

もう一つの書き方も試しました。Combination_DP.pya = [2,9,4,5,1,6,10] N = len(a) memo = [0]*(N) for i in range(N-1): memo[i+1]=memo[i]+abs(a[i+1]-a[i]) if i >= 1 : memo[i+1] = min(memo[i+1],memo[i-1]+abs(a[i+1]-a[i-1])) print(memo[N-1])私は冒頭にあるメモの概念と、

以下のアプローチをイメージ出来たら理解した気分になれました(笑)Step 1. +1 のコストを最初に memo

Step 2. +2 のコストと Step 1 で求めた memo を比較して小さい方の値を上書きまだまだ、足を踏み入れたばかりなので、

もう少し違う問題も挑戦しようと思います。

- 投稿日:2020-11-25T23:07:05+09:00

pythonエンジニア認定基礎試験に合格した

python認定エンジニア試験を受験しようと思ったきっかけ

面接でpythonを使ってアンケートを分析したことがあると言った際に、面接官の方から「python認定エンジニア試験を受験してみたら?」と勧められたので。

勉強を始める前のレベル

PyQと言うpythonを学べるサイトでpythonの文法やデータ分析について一通り学んでおり、基礎的な知識は身に付いている程度。ただ、文法は自信がないものの、pythonを使っての分析は実際に使えるレベル。

勉強方法

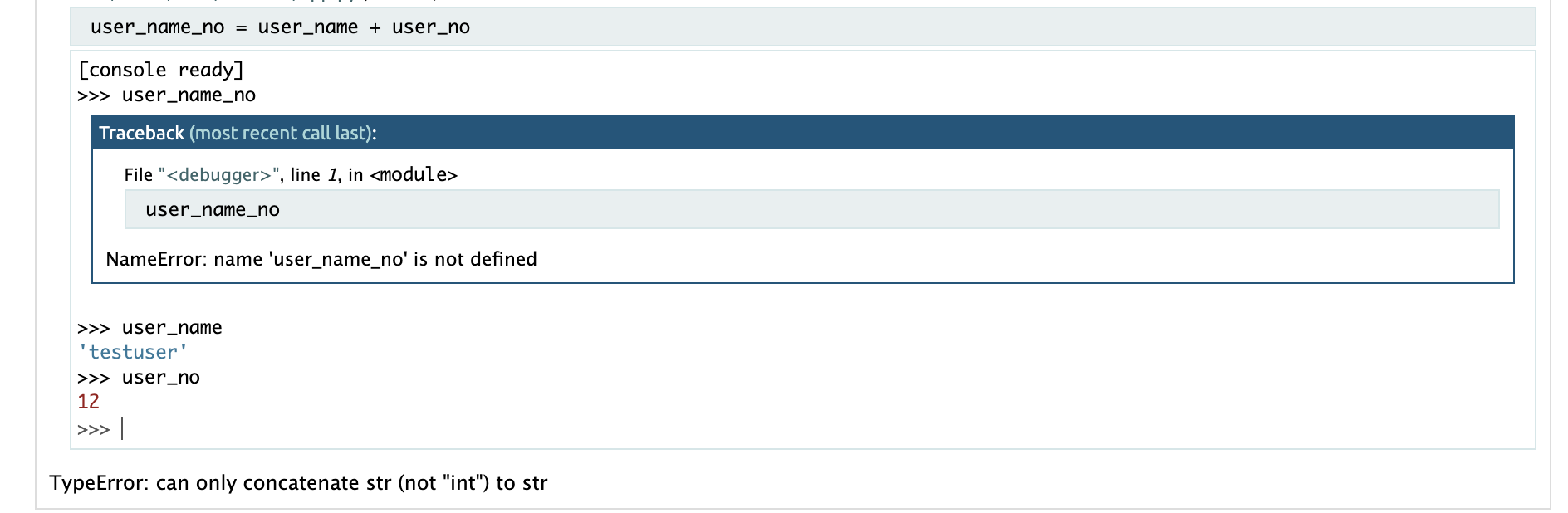

pythonチュートリアルを読みながら、理解できないコードを実際に動かしながらやってました。テキストにあるコードを頭の中でどのような処理がされるのか、を自分で理解するまで動かしました。デバック機能を使いまくり、とにかく納得するまでやるのが良いかなと思います。

一通りテキストを読んで、コードを動かしたあとは公式ホームページにある模擬テストを一日一回やってました。間違えた問題をどこが間違っているのか、なんで正解したのかを徹底的に分析したのが重要だと思います。あと、問題は必ずテキストを基に作られているので、間違えた問題を参考にテキストにマーカーを引いて、後日見直しをしました。実際に受験して

1000点中の900点でした。残りの100点、何を間違えてたんだ。時間は60分ありますが、見直ししても30分ほど余裕がありました。すぐに結果がわかるので、終了のタイミングを伸ばし伸ばしにしてしまいます笑

受験日は会場によってはほぼ毎日受けられるところもあるので要確認です。一番最初に受験日を決めて勉強するのが良いと思います。

- 投稿日:2020-11-25T23:05:31+09:00

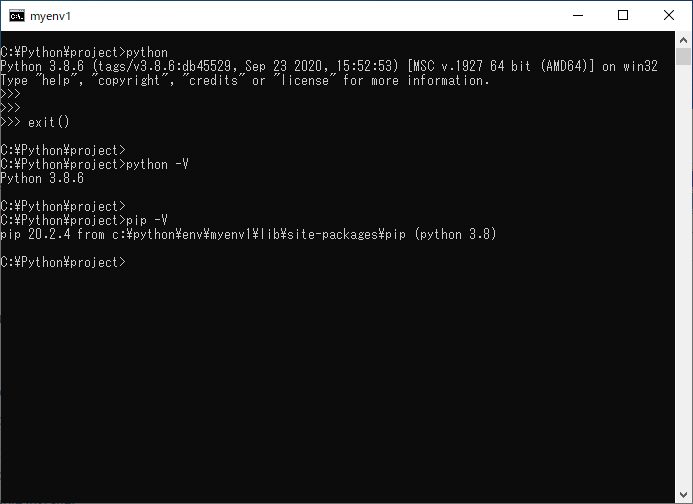

Window環境でなるべく汚さずPython環境を乱立させる。

0. はじめに

0-1. やること

Windowsで出来る限り環境を汚さず、Python環境を乱立させます。

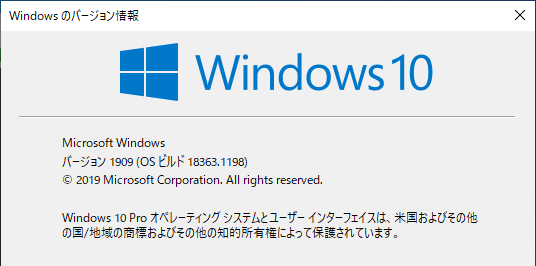

0-2. 動作検証環境

Window 10 Pro Ver 1909 (Build 18363.1198)

1. 手順

1-1. 作業フォルダの作成

お好みでフォルダを作成する。

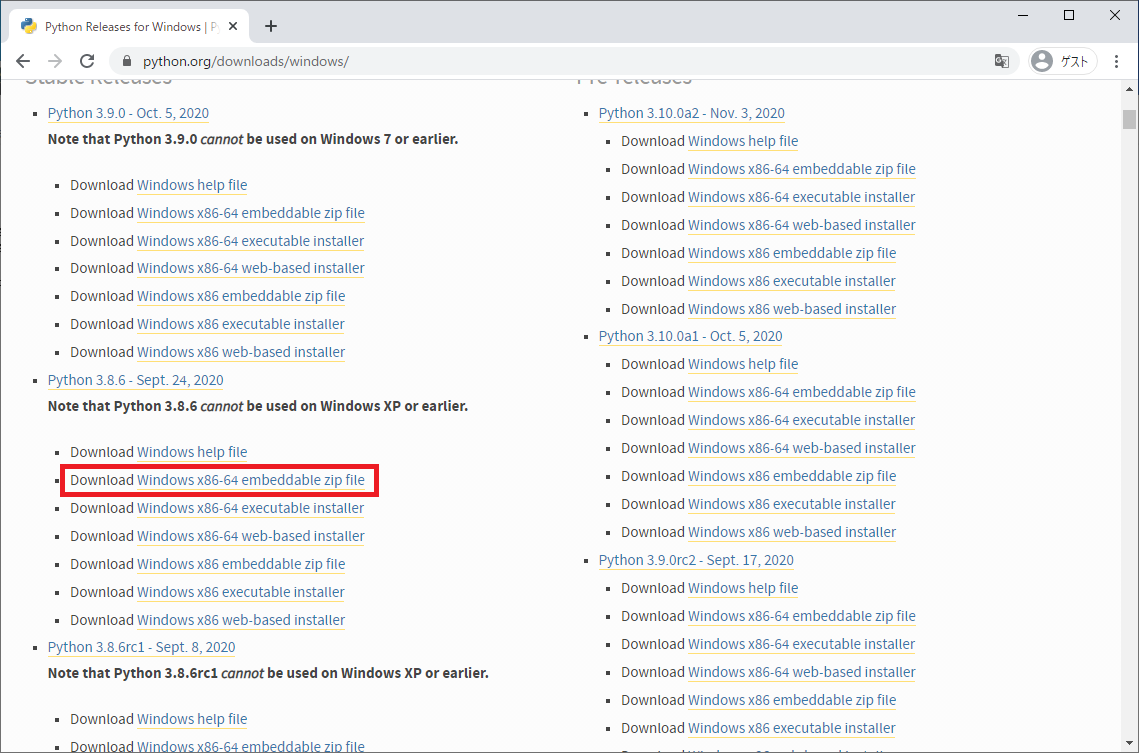

C:\Python ├ env ←Python格納フォルダ └ project ←スクリプトファイル(*.py)格納フォルダ1-2. Pythonのダウンロード

以下のURLより、使用したいバージョンの「embeddable zip file」をダウンロードする。

例:python-3.8.6-embed-amd64.zip

https://www.python.org/downloads/windows/

1-3. 資材の格納

ダウンロードしたzipファイルを解凍し、envフォルダ配下に格納する。

env直下にpython.exe等を配置するのではなく、お好みの環境名称のサブフォルダを切って格納してください。

以下の例では、「python-3.8.6」という名称のフォルダ配下に個々のファイルがあるイメージです。C:\Python ├ env │ └ python-3.8.6 ←例えば、「python-3.8.6」という名称のフォルダにして格納する。 └ project1-4. 起動用batの作成

デスクトップ等、起動しやすい場所に以下を作成する。

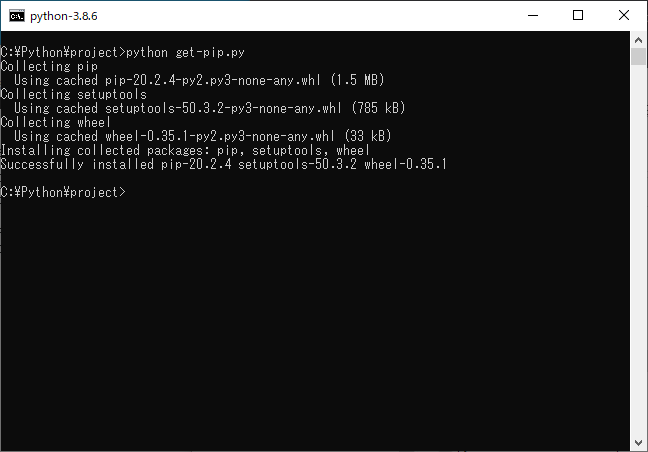

1-3で作成した環境名(フォルダ名)をbatファイル名にしてください。python-3.8.6.bat@echo off cls set envname=%~n0 set work_dir=C:\Python\project set python_dir=C:\Python\env\%envname% set script_dir=C:\Python\env\%envname%\Scripts set PATH=%python_dir%;%script_dir%;%PATH% cd /d %work_dir% cmd /k title %envname%1-5. pipのインストール

1-5-1. get-pip.pyの取得

以下のURLよりget-pip.pyをダウンロードし、projectフォルダに格納する。

https://bootstrap.pypa.io/get-pip.pyC:\Python ├ env │ └ python-3.8.6 └ project └ get-pip.py1-5-2. コンフィグ修正

C:\Python\env\python-3.8.6\python38.pthをテキストエディタで開き、5行目のコメントアウトを解除(#を削除)する。

フォルダ名・環境名は適宜読み替えてください。

python**.pthの*はPythonのバージョンにより異なります。

(Python 3.8.ならpython38.pth、Python 3.9.*ならpython39.pth)1-5-3. get-pip.pyの実行

で作成したbatを起動し、pipをインストールする。

> python get-pip.py1-6. 環境を乱立させる!

同様の手順でenv配下にお好きな環境を作成する。

削除したければフォルダ削除でOK。

環境の起動(切り替え?)は1-4で作成するbatの選択を変えるだけ。

(batのフォルダ名とenv配下のフォルダ名を合わせるだけ)C:\Python ├ env │ ├ python-3.8.6 │ ├ python-3.7.9 │ ├ myenv1 │ ├ myenv2 │ └ myenv3 └ project └ get-pip.py2. ポイント

- embeddable版にはインストール版と異なる制約もありますが、ちょっと触ってみるくらいであれば問題なさそうです。

- python資材そのものを分けて使用する為、venv等の仮想機能は使用しません(できません)。その代わり、バージョン自体を混在させる(Python 3.7とPython 3.8等)ことは容易です。

- 資材を置くだけなので本来はフルパスで呼び出すかパスを通さないと実行できません。この手順内ではbatで環境変数をいじっていますが、同プロンプト内でしか有効になりません。(故に環境を汚しません)

- 意図した環境が動いているか自信がない場合には、pip -Vコマンドを実行すればインストール先フォルダパスも表示されるので確認できます。(一応コマンドプロンプトの枠にも表示しています。)

- 環境名(フォルダ名)を変更した場合には、pipを再インストール(get-pip.pyを再実行してください。

- project配下に自作のスクリプトを格納していくイメージです。同フォルダ内の別スクリプトファイルをimportする場合には、適切にパスを追加するか、各環境のフォルダ直下に以下のpthファイル(ファイル名は任意)を作成しておけば解消できるようです。

current.pthimport sys; sys.path.append('')3. 参考

Windowsで環境を極力汚さずにPythonを動かす方法 (Python embeddable版)

https://qiita.com/rhene/items/68941aced93ccc9c3071

超軽量、超高速な配布用Python「embeddable python」

https://qiita.com/mm_sys/items/1fd3a50a930dac3db299

- 投稿日:2020-11-25T23:05:24+09:00

Flaskで作るSNS Flask(Template)編

初めに

Udemyの下記講座の受講記録

Python+FlaskでのWebアプリケーション開発講座!!~0からFlaskをマスターしてSNSを作成する~

https://www.udemy.com/course/flaskpythonweb/この記事ではFlaskのView側(Template側)について記載する。

Flaskとは

- PythonのWebフレームワーク

MVT(モデル・ビュー・テンプレート)

Model:データ挿入、更新、削除など、データベースにアクセスする処理を実行する。

View:ユーザーの入力を受け付け、処理に必要なモデルを呼び出し、その結果をTemplateに渡す。

Template:Viewから渡されたデータをもとに動的にページを作成してユーザーに結果を表示する。

Tutorial

from flask import Flask app = Flask(__name__) @app.route('/') def index(): return '<h1>Hello World!</h1>' if __name__ == '__main__': app.run(host='0.0.0.0', port=5000, debug=True)

hostには’0.0.0.0'を指定する。ただし、'0.0.0.0'はどんな接続でも受け入れる状態のことで、厳密には有効なアドレスではないらしい。

'0.0.0.0'と同様に、'127.0.0.1'というhostもよく利用される。

'127.0.0.1'は、自分自身を指すIPアドレスである。そのため、自分自身のサービスが動作しているかどうかを確認したり、自分自身のコンピュータ上で動作しているサービスへ接続する場合に利用したりできる。どちらのhostアドレスもURL上'localhost'に置き換えて接続できる。

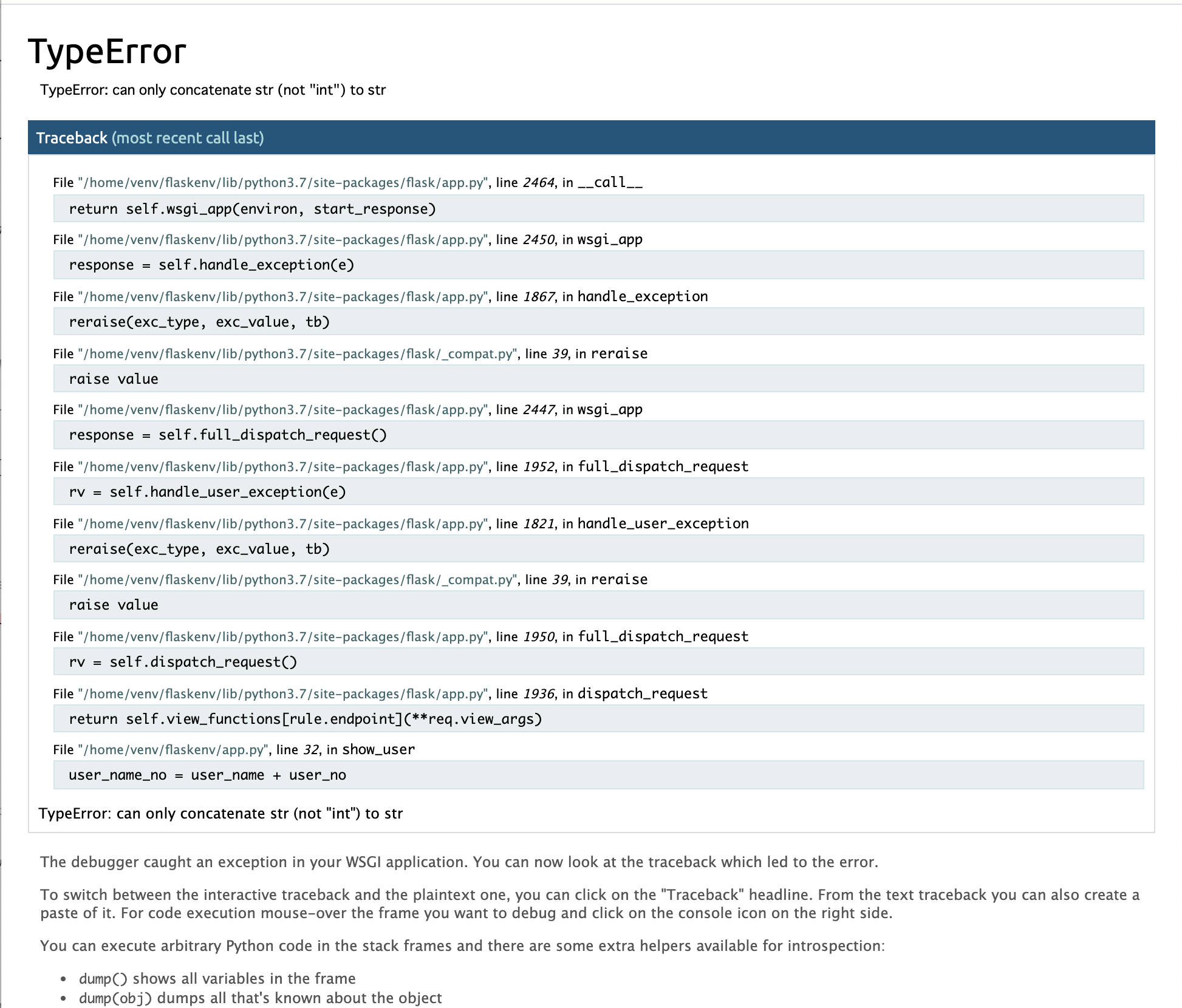

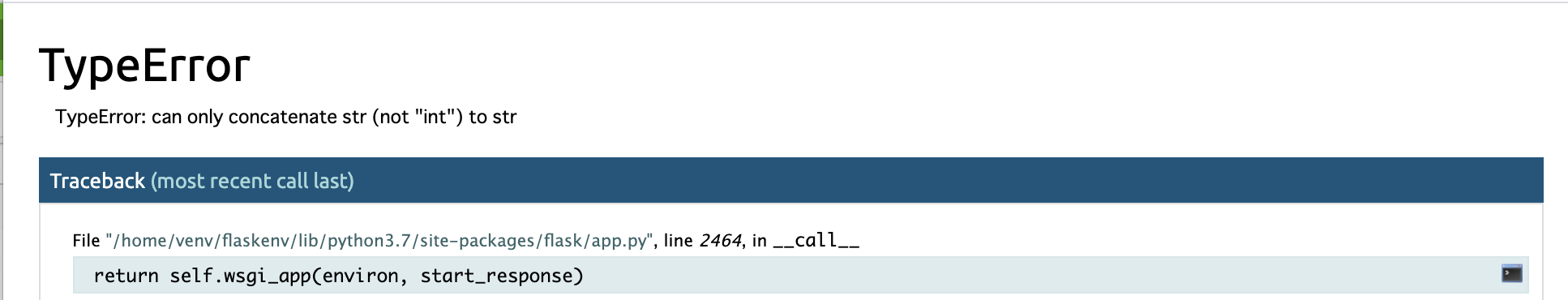

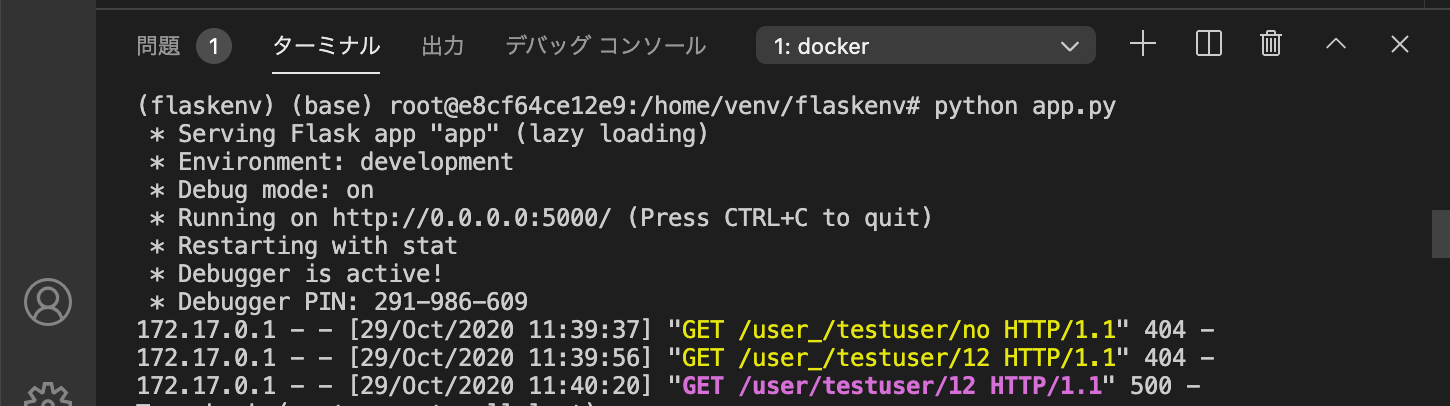

debug=True によるデバッグ

app.run()にデバッグオプション"debug=True"を設定することで、エラーが発生した時にブラウザにエラーの詳細が表示されるようになる。

水色の行にカーソルを当てると、右端にコンソールのアイコンが表示される。

このアイコンを選択して表示される画面に、コンソールに表示されているPINを入力すると、ブラウザ上でコンソール入力によるデバッグが可能となる。ルーティング

#1つのメソッドにルーティングを複数指定することも可能 @app.route('/') @app.route('/hello') def index(): return '<h1>Hello World!</h1>' #URLのパラメータに応じて表示を変更する @app.route('/post_name/<post_name>') def show_post_name(post_name): print(type(post_name)) return '<h1>{}</h1>'.format(post_name) #パラメータのデータ型をして可能(デフォルトはstring) #指定したデータ型以外が渡された場合はNotFoundになる。 @app.route('/post_id/<int:post_id>') def show_post_id(post_id): print(type(post_id)) return '<h1>{}</h1>'.format(post_id) #ルーティングで複数のパラメータを取得することも可能 @app.route('/post_data/<int:post_id>/<post_name>') def show_post_data(post_id, post_name): return '<h1>{}`s id = {}</h1>'.format(post_name, post_id)テンプレート

- Flaskで利用するHTMLファイル。

- Jinjaというライブラリを使用している。

- Templatesフォルダ配下に格納する。

- "render_template()"メソッドで処理で使用するテンプレートファイルを指定する。

@app.route('/') def index(): return render_template('index.html')

- テンプレートを格納するフォルダ名は基本的に”Templates"だが、別名に変更したい場合は、appにFlaskを代入する際に変更後のフォルダを指定する。

#テンプレートを格納するフォルダを'Template_2'に変更する例 app = Flask(__name__, template_folder='Template_2'テンプレートへの引数の受け渡し

- Template側では、受け取った変数を表示する箇所を"{{ 変数名 }}"と記入する。

- スクリプト側では、render_template()でテンプレートの後にカンマ区切りで"テンプレート側変数名=スクリプト側変数名"の形式で記入する。

@app.route('/home/<string:user_name>') def home(user_name): login_user = user_name return render_template('home.html', user_name = login_user)辞書型変数を使用する場合

@app.route('/home/<string:user_name>/<int:age>') def home(user_name, age): login_user ={ 'name': user_name ,'age': age } return render_template('home.html', user_info = login_user)<!DOCTYPE html> <html lang="ja"> <head> <meta charset="UTF-8"> <meta name="viewport" content="width=device-width, initial-scale=1.0"> <title>Flask Page</title> </head> <body> <h1>{{user_info.name}}({{user_info['age']}})さんがログインしました</h1> </body> </html>辞書型変数から特定の要素を取得する場合は、以下どちらの形式でも良い。

- 辞書変数名.キー

- 辞書変数名[キー]

テンプレート内への制御構文埋め込み

- {% %} : if,forなどの制御構文埋め込み

- {{ }} : 変数の埋め込み

- {# #} : コメント

def user_list(): users = ['Taro2','Jiro','Sabro','Shiro'] is_login = True return render_template('userlist.html', users = users, is_login = is_login)<body> <ul> {% for user in users %} <li>{{ user }}</li> {% endfor %} </ul> {# 制御構文に終了タグが必要になる。(endfor, endifなど) #} {% if is_login %} <p>ログイン済みです</p> {% else %} <p>ログインしていません</p> {% endif %} {% if 'Taro' in users %} <p>Taro is Exist.</p> {% endif %} </body>テンプレートの継承

- 継承元テンプレートに"{% block content %} --- {% end block %}"

- 継承先テンプレートに"{% extend '継承先テンプレート' %} --- {% block content %} --- {% end block %}"

- "content"はブロックごとに異なる名称を設定する。継承元に定義されているブロックと同じ名称が設定されている継承先のブロックが反映される。

- 継承元の要素利用したい(例えば、継承元の"title"タグに記載されている内容を継承先でも行事したい場合)は、"{{ super() }}"タグを利用する。

#base.html <!-- 継承元 --> <html> <head> <!-- 継承元の要素を利用したい場合は、"{{ super() }}"を使用する。 --> {% block title %}{% page_title %}{{ super() }} {% endblock %} </head> <body> {% block content %} ここに継承先ファイルの内容が埋め込まれる {% endblock %} </body> </html> #sub.html <!-- 継承先 --> {% extends "template.html" %} {% block content %} ここに継承先ファイルに埋め込む内容を記入する {% endblock %} {% block subcontent %} 複数ブロック存在する場合は異なるブロック名称を設定する。 {% endblock %}継承元

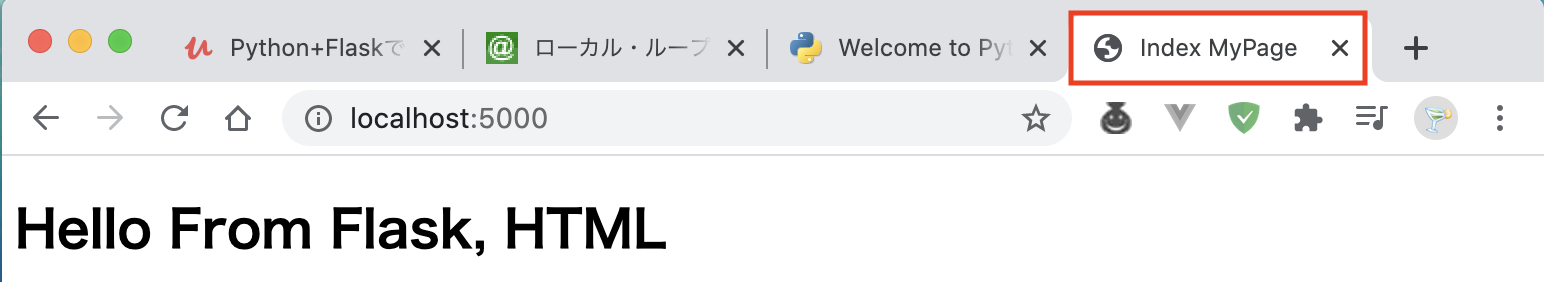

<!DOCTYPE html> <html lang="ja"> <head> <meta charset="UTF-8"> <meta name="viewport" content="width=device-width, initial-scale=1.0"> <title>{% block title %}MyPage{% endblock %}</title> </head> <body> {% block content %} {% endblock %} </body> </html>継承先

{% extends 'base.html' %} {% block title %}Index {{ super() }}{% endblock %} {% block content %} <h1>Hello From Flask, HTML</h1> {% endblock %}結果

赤枠内でsuper()を使用することで継承先で指定した文字だけでなく継承元の要素であるもじもはんえいされていることが確認できる。フィルター

- "{% 変数 | フィルター %}"の形式で記載することで、変数そのものは変更せずに、表示だけフィルターで処理した結果を表示することが可能。

- "{% filter filter名%} {% block contetnt %}~{%endblock%} {% endfilter %}"とすることで、ブロック全体にフィルターの効果を反映することができる。

{# ブロック単位でフィルターを適用する場合 #} {# {% filter upper %} #} {% block content %} {# 個別にフィルターを適用する場合 #} <h1>Hello From Flask, HTML</h1> <!-- 大文字 --> <h1>{{ "Hello From Flask, HTML on filter-upper" | upper}}</h1> <!-- 文頭のみ大文字 --> <h1>{{ "Hello From Flask, HTML on filter-capitalize" | capitalize}}</h1> <!-- 単語の先頭のみ大文字 --> <h1>{{ "Hello From Flask, HTML on filter-title" | title}}</h1> <!-- 小文字 --> <h1>{{ "Hello From Flask, HTML on filter-lower" | lower}}</h1> <!-- 変数に値が設定されていない場合のデフォルト値 --> <p>{{ user|default("valiable user does not Exist") }}</p> <!-- urlのリンク化。(target="_blak")追加で新規タブで開く --> <p>{{ 'jinja : https://jinja.palletsprojects.com/en/2.11.x/' | urlize(target="_blank")}}</p> {% endblock %} {# {% endfilter %} #}{% block content %} <h1>先頭の人:{{users | first}}</h1> <h1>最後の人:{{users | last}}</h1> <h1>ソートして先頭の人:{{users | sort | first}}</h1> <h1>ランダム:{{users | random}}</h1> <ul> {# フィルタで逆順にソートしてセットする #} {% for user in users | reverse %} {# userの"Ta"を"Go"に置換 #} <li>{{ user | replace('Ta', 'Go')}}</li> {% endfor %} </ul> {# 制御構文に終了タグが必要になる。(endfor, endifなど) #} {% if is_login %} <p>ログイン済みです</p> {% else %} <p>ログインしていません</p> {% endif %} {% if 'Taro' in users %} <p>Taro is Exist.</p> {% endif %} {% endblock %}カスタムフィルター

独自のフィルターを作成する事ができる。

作成したフィルタの使用方法は組み込みフィルタと同様。from datetime import datetime #文字列を反転させるフィルタ @app.template_filter('reverse_name') def reverse(name): return name[-1::-1] @app.template_filter('birth_year') def calc_birth_year(age): now_timestamp = datetime.now() return str(now_timestamp.year - int(age)) + '年'<!-- 誕生年を表示する(birth_year) --> {% for user in users %} <li>{{user.name}} {{user.age}} born at {{user.age | birth_year}}</li> {% endfor %} {% for user in users | reverse %} <!-- userの"Ta"を"Go"に置換 --> <li>{{ user | reverse | replace('Ta', 'Go')}}</li> {% endfor %}画面遷移・エラーハンドリング

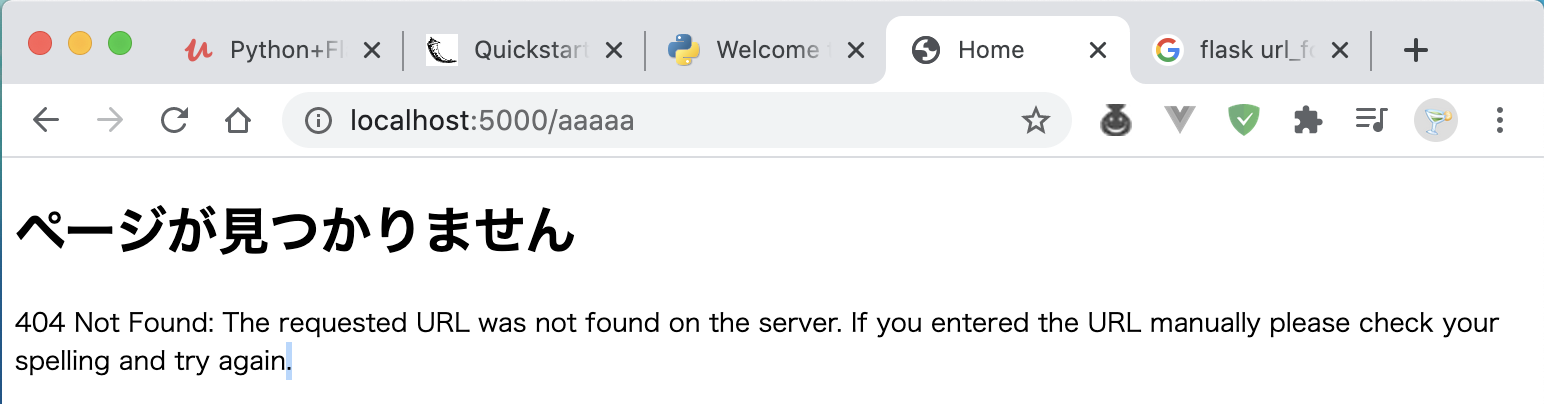

指定した関数のページに遷移 <a href="{{ url_for('index')}}">New page </a> <!-- app.pyの下記関数のこと @app.route('/') def index(): return render_template('index.html') --> 画像ファイルを表示(静的ファイルを読み込む場合は第1引数は'static'とする) <img src="{{ url_for('static', filename=ファイルパス}}">from flask import Flask, render_template, redirect, url_for, abort #リダイレクト return redirect(url_for('info', variable='man')) #指定したエラーを発生させるメソッド #設定したメッセージはエラーハンドラーで"error.description"とすることで取得可能 abort(エラー番号, メッセージ) #エラーハンドラー(エラー発生時に関数を呼び出す) #関数の引数にはエラーオブジェクトを渡すことが必須。(引数名は任意) #’エラー番号'にはコンソールに表示されているエラー番号を設定する。 @app.errorhandler(エラー番号) def page_not_found(e): return render_template('not_found.html')[,サーバーに返すエラー番号(ステータスコード)]例1

@app.route('/user/<string:user_name>/<int:age>') def user(user_name, age): if user_name in ['Taro','Jiro','Saburo']: #homeメソッドのurlにリダイレクトする return redirect(url_for('home', user_name=user_name, age=age)) else: #特定のエラーを発生させる abort(500, 'リダイレクト不可のユーザー') @app.errorhandler(500) def system_error(error): #上記abortメソッドで設定したメッセージを取得する。 error_description = error.description return render_template('system_error.html', error_description=error_description), 500例2

@app.errorhandler(404) #引数にerrorオブジェクトは必須 def page_not_found(e): #404エラー発生時に以下のテンプレートページを開く。戻り値として404を返す。 return render_template('page_not_found.html', error=e), 404{% extends 'base.html' %} {% block title %}Not Found{% endblock %} {% block content %} <h1>ページが見つかりません</h1> <p>{{ error }}</p> {% endblock %}Form

Templateに作成している入力フォームから送信されたリクエストを取得する。

#リクエストデータを取得するモジュール from flask import request #GETリクエスト var = request.args.get('フォーム名') #POSTリクエスト var = rwquest.form.get('フォーム名') #リクエストのタイプを確認する(GETかPOSTか) request.method #関数が受け付けるリクエストのタイプを指定する(デフォルトは'GET') @app.route('/',methods=['GET','POST']例

@app.route('/home') _def home(): print(request.full_path) print(request.method) print(request.args) return render_template('home.html')実行結果

#request.full_path 172.17.0.1 - - [08/Nov/2020 14:33:58] "GET / HTTP/1.1" 200 - /home?last_name=yamada&first_name=taro&job=%E5%85%AC%E5%8B%99%E5%93%A1&gender=%E7%94%B7%E6%80%A7&message=this+is+a+pen. #request.method GET #request.args ImmutableMultiDict([('last_name', 'yamada'), ('first_name', 'taro'), ('job', '公務員'), ('gender', '男性'), ('message', 'this is a pen.')]) 172.17.0.1 - - [08/Nov/2020 14:34:24] "GET /home?last_name=yamada&first_name=taro&job=公務員&gender=男性&message=this+is+a+pen. HTTP/1.1" 200 -POSTメソッドにしたい場合

requestをPOSTにしたい場合は、formタグのmethod属性に’POST'を指定する。{% extends 'base.html' %} {% block content %} <h1>サインアップページ</h1> <form action='{{ url_for("home") }}' method='POST'> ・・・#'method'ではなく'methods'。's'を忘れない。 #'[]'も必須。 #デフォルト(省略時)は'GET' @app.route('/home', methods=['GET','POST']) def home():結果(コンソールで確認)

172.17.0.1 - - [08/Nov/2020 15:31:30] "GET / HTTP/1.1" 200 - /home? POST ImmutableMultiDict([])ファイルアップロード

secure_filename(ファイル名)

'werkzeug'というWSGIライブラリのメソッド。(Flaskをインストールすると一緒についてくる。)

ファイル名を安全な形に変換する処理。ただし、日本語には対応していないため、日本語名称が設定されているファイルがアップロード対象になる可能性がある場合は、別のライブラリで事前に対処しておく必要がある。

→pykakasipykakasi

漢字や平仮名など、日本語を指定した文字に変換してくれるライブラリ。import pykakasi kakasi = pykakasi.kakasi() kakasi.setMode('H','a') #ひらがなをアルファベット小文字に変換 kakasi.setMode('K','a') #カナ文字をアルファベット小文字に変換 kakasi.setMode('J','a') #漢字をアルファベット小文字に変換 conv = kakasi.getConverter() conv.do('テスト') >'tesuto' conv.do('案山子') >'kakashi'HTML側

<form method='POST' enctype='multipart/form-data'> <input type="file" name='file'> <input type="submit" value='アップロード'> </form>Python側

from werkzeug.utils import secure_filename import pykakasi class Kakasi: kakasi = pykakasi.kakasi() kakasi.setMode('H', 'a') kakasi.setMode('K', 'a') kakasi.setMode('J', 'a') conv = kakasi.getConverter() ### 省略 ### @app.route('/upload', methods=['GET','POST']) def upload(): if request.method == 'GET': return render_template('upload.html') elif request.method == 'POST': #requestからファイルアップロード情報を取得 file = request.files['file'] #日本語ファイル名をascii表記に変換する。 convert_file_name = Kakasi.japanese_to_ascii(file.filename) #ファイル名を安全な内容に変換 save_filename = secure_filename(convert_file_name) #osモジュールのjoin処理で保存するファイルパスを作成し、saveで保存 file.save(os.path.join('./static/images', save_filename))wtforms

フォームの実装簡略化、XSSなどのセキュリティ対策として有効なライブラリ

https://wtforms.readthedocs.io/en/2.3.x/fields/例えば以下のタグが、

<form method='POST'> <label for='name'>名前</label> <input type='text' name='name'> </form>wtforms.Formを使えば、以下のように記述できる

<form method='POST'> {{ form.name.label }} {{form.name()} </form>pythonのスクリプトは下記の通り(一部省略)

from flask import Flask, render_template, request from wtforms import StringField, SubmitField,IntegerField from wtforms.form import Form class UserForm(Form): name = StringField('名前') return render_template('index.html', form=form, name=name)'form.name.label' には、スクリプト側で「〜Field」として定義した時に指定した名称が表示される。

csrf対策

<form action="" method='POST'> <!--フォームの先頭に記述する --> {{ form.csrf_token }} {{ form.name.label }}{{ form.name() }} {{ form.age.label }}{{ form.age() }} {{ form.submit()}} </form>template関数とセッション

template関数とは、ビューヘルパーのこと。

複数のTemplateで共通的に使用したい部分を別ファイルに切り出しておいて、使いたい時にインポートして使用することができる。

- template関数の宣言は"macro func_name(arg)"

- xxx | safe : エスケープ処理を行わない

Template関数

{% macro render_field(field) %} <dt>{{ field.label }}</dt> <dd>{{ field(**kwargs) | safe}}</dd> {% if field.errors %} <ul class="error"> {% for error in field.errors %} <li>{{ error }}</li> {% endfor %} </ul> {% endif %} {% endmacro %}Template

{% extends 'base.html' %} <!-- template関数(ヘルパー)をインポートする --> {% from '_formhelpers.html' import render_field %} {% block content %} <form method="POST"> {{ form.csrf_token }} <!-- temlate関数の処理が適用される。 --> {{ render_field(form.name) }} {{ form.submit }} </form> {% endblock %}スクリプト

class UserForm(Form): name = StringField('名前:') age = IntegerField('年齢:') password = PasswordField('パスワード:') birthday = DateField('誕生日:', format='%Y/%m/%d') gender = RadioField('性別:', choices=[('man', '男性'), ('woman', '女性')]) major = SelectField( '専攻', choices=[('bungaku', '文学部'), ('hougaku', '法学部'), ('rigaku', '理学部')]) is_japanese = BooleanField('日本人?:') message = TextAreaField('メッセージ:') submit = SubmitField('送信') @app.route('/', methods=['GET', 'POST']) def index(): form = UserForm(request.form) # POSTされたデータをセッションに格納する。 if request.method == 'POST' and form.validate(): session['name'] = form.name.data session['age'] = form.age.data session['password'] = form.password.data session['birthday'] = form.birthday.data session['gender'] = form.gender.data session['major'] = form.major.data session['nationality'] = '日本人' if form.is_japanese.data else '外国人' session['message'] = form.message.data return redirect(url_for('show_user')) return render_template('user_regist.html', form=form)Fieldのいろいろ

<!-- formのサイズ(幅)を指定する --> <form method="POST"> {{ form.csrf_token }} {# temlate関数の処理がそれぞれに適用される。 #} {{ render_field(form.name, size=100) }} <!-- template関数(render_field)を使用しない場合 --> <!-- {{ form.age(size=200)}} -->from wtforms import Form, widgets class UserForm(Form): #デフォルト値設定 name = StringField('名前:', default='山田花子') #placeholder設定(render_kwに辞書型として設定する) birthday = DateField('誕生日:', format='%Y/%m/%d',render_kw={'placeholder': 'yyy/mm/dd'}) #formをTextAreaタイプに変更する name = StringField('名前:', widget=widgets.TextArea())<!-- 初期値(チェックボックス) --> {{ render_field(form.is_japanese,checked=true) }} <!-- タグのクラス属性を追加 --> {{ render_field(form.age, class='age-class') }}バリデーション

組み込みバリデーション

Flaskにもともと定義されているバリデーション。from wtforms.validators import DataRequired, EqualTo, Length, NumberRange, ValidationError class UserForm(Form): name = StringField('名前:', widget=widgets.TextArea(), validators=[ DataRequired('データを入力してください')], default='山田花子') age = IntegerField('年齢:', validators=[NumberRange(0, 100, '入力値が不正です')]) password = PasswordField('パスワード:', validators=[ Length(4, 10, '4文字以上10文字以下'), EqualTo('confirm_password', 'パスワード不一致')]) confirm_password = PasswordField('再入力', validators=[])https://wtforms.readthedocs.io/en/2.3.x/validators/#custom-validators

自作バリデーション

独自のバリデーションを作成したい場合に、関数とおなじように作成することが可能。クラス内でバリデーションを定義する場合

#フォーマット def validate_<対象フォーム名>(form, field): <処理> raise ValidattionError('エラーメッセージ')#作成例 class UserForm(Form): name = StringField('名前:', widget=widgets.TextArea(), default='山田花子') # 自作バリデーション def validate_name(form, field): if field.data == 'nanashi': raise ValidationError('この名前は使用できません。')クラスの外でバリデーションを定義する場合

def validate_<対象フォーム名>(form, field): <処理> raise ValidationError('エラーメッセージ')def validate_name(form, field): if field.data == 'nanashi2': raise ValidationError('その名前も使用できません') class UserForm(Form): name = StringField('名前:', widget=widgets.TextArea(), validators=[validate_name,DataRequired('データを入力してください')], default='山田花子')

- 投稿日:2020-11-25T22:52:32+09:00

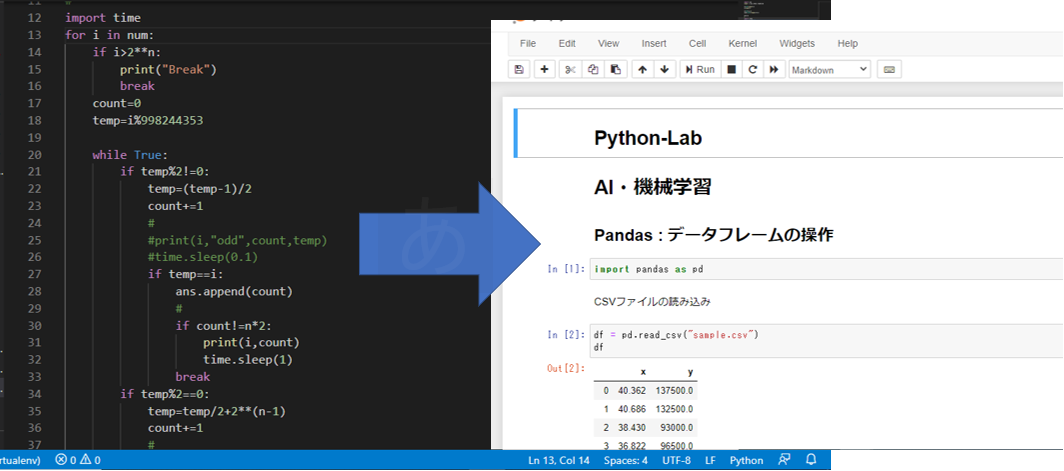

Pandas DataFrameのすべてのメソッドとそれぞれに渡せる引数を調べた

Pandas DataFrameのすべてのメソッドとそれぞれに渡せる引数について調べました。

知っているメソッドしか使わないので、他のメソッドも調べて積極的に使っていきたいと思います。以下、方法と結果です。

方法

下記ファイルを実行するとinspectモジュールを使って自動で調べてくれます。

main.py# coding: utf-8 import inspect import pandas as pd def main(): print(123) df = pd.DataFrame({ "col1":[i for i in range(10)], "col2":[i*2 for i in range(10)], }) print(df) print(dir(df)) df_methods = dir(df) print(len(dir(df)),dir(df)) n = 1 for i,method in enumerate(df_methods): if not '_' in method and method != 'T': try: exec("inspect.getfullargspec(df.%s)"%(method)) print("%s番目のメソッド: %s"%(n,method)) exec("print(' df.'+method+'の受け取れる引数:',inspect.getfullargspec(df.%s))"%(method)) n += 1 except: pass print("") return "Hello World!" if __name__ == "__main__": main()https://docs.python.org/3/library/inspect.html

結果

1番目のメソッド: abs df.absの受け取れる引数: FullArgSpec(args=['self'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries}) 2番目のメソッド: add df.addの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 3番目のメソッド: agg df.aggの受け取れる引数: FullArgSpec(args=['self', 'func', 'axis'], varargs='args', varkw='kwargs', defaults=(None, 0), kwonlyargs=[], kwonlydefaults=None, annotations={}) 4番目のメソッド: aggregate df.aggregateの受け取れる引数: FullArgSpec(args=['self', 'func', 'axis'], varargs='args', varkw='kwargs', defaults=(None, 0), kwonlyargs=[], kwonlydefaults=None, annotations={}) 5番目のメソッド: align df.alignの受け取れる引数: FullArgSpec(args=['self', 'other', 'join', 'axis', 'level', 'copy', 'fill_value', 'method', 'limit', 'fill_axis', 'broadcast_axis'], varargs=None, varkw=None, defaults=('outer', None, None, True, None, None, None, 0, None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 6番目のメソッド: all df.allの受け取れる引数: FullArgSpec(args=['self', 'axis', 'bool_only', 'skipna', 'level'], varargs=None, varkw='kwargs', defaults=(0, None, True, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 7番目のメソッド: any df.anyの受け取れる引数: FullArgSpec(args=['self', 'axis', 'bool_only', 'skipna', 'level'], varargs=None, varkw='kwargs', defaults=(0, None, True, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 8番目のメソッド: append df.appendの受け取れる引数: FullArgSpec(args=['self', 'other', 'ignore_index', 'verify_integrity', 'sort'], varargs=None, varkw=None, defaults=(False, False, False), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 9番目のメソッド: apply df.applyの受け取れる引数: FullArgSpec(args=['self', 'func', 'axis', 'raw', 'result_type', 'args'], varargs=None, varkw='kwds', defaults=(0, False, None, ()), kwonlyargs=[], kwonlydefaults=None, annotations={}) 10番目のメソッド: applymap df.applymapの受け取れる引数: FullArgSpec(args=['self', 'func'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 11番目のメソッド: asfreq df.asfreqの受け取れる引数: FullArgSpec(args=['self', 'freq', 'method', 'how', 'normalize', 'fill_value'], varargs=None, varkw=None, defaults=(None, None, False, None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries, 'how': typing.Union[str, NoneType], 'normalize': <class 'bool'>}) 12番目のメソッド: asof df.asofの受け取れる引数: FullArgSpec(args=['self', 'where', 'subset'], varargs=None, varkw=None, defaults=(None,), kwonlyargs=[], kwonlydefaults=None, annotations={}) 13番目のメソッド: assign df.assignの受け取れる引数: FullArgSpec(args=['self'], varargs=None, varkw='kwargs', defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 14番目のメソッド: astype df.astypeの受け取れる引数: FullArgSpec(args=['self', 'dtype', 'copy', 'errors'], varargs=None, varkw=None, defaults=(True, 'raise'), kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries, 'copy': <class 'bool'>, 'errors': <class 'str'>}) 15番目のメソッド: backfill df.backfillの受け取れる引数: FullArgSpec(args=['self', 'axis', 'inplace', 'limit', 'downcast'], varargs=None, varkw=None, defaults=(None, False, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': typing.Union[~FrameOrSeries, NoneType], 'self': ~FrameOrSeries, 'inplace': <class 'bool'>}) 16番目のメソッド: bfill df.bfillの受け取れる引数: FullArgSpec(args=['self', 'axis', 'inplace', 'limit', 'downcast'], varargs=None, varkw=None, defaults=(None, False, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': typing.Union[~FrameOrSeries, NoneType], 'self': ~FrameOrSeries, 'inplace': <class 'bool'>}) 17番目のメソッド: bool df.boolの受け取れる引数: FullArgSpec(args=['self'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={}) 18番目のメソッド: boxplot df.boxplotの受け取れる引数: FullArgSpec(args=['self', 'column', 'by', 'ax', 'fontsize', 'rot', 'grid', 'figsize', 'layout', 'return_type', 'backend'], varargs=None, varkw='kwargs', defaults=(None, None, None, None, 0, True, None, None, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 19番目のメソッド: clip df.clipの受け取れる引数: FullArgSpec(args=['self', 'lower', 'upper', 'axis', 'inplace'], varargs='args', varkw='kwargs', defaults=(None, None, None, False), kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries, 'inplace': <class 'bool'>}) 20番目のメソッド: combine df.combineの受け取れる引数: FullArgSpec(args=['self', 'other', 'func', 'fill_value', 'overwrite'], varargs=None, varkw=None, defaults=(None, True), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame', 'other': 'DataFrame'}) 21番目のメソッド: compare df.compareの受け取れる引数: FullArgSpec(args=['self', 'other', 'align_axis', 'keep_shape', 'keep_equal'], varargs=None, varkw=None, defaults=(1, False, False), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame', 'other': 'DataFrame', 'align_axis': typing.Union[str, int], 'keep_shape': <class 'bool'>, 'keep_equal': <class 'bool'>}) 22番目のメソッド: copy df.copyの受け取れる引数: FullArgSpec(args=['self', 'deep'], varargs=None, varkw=None, defaults=(True,), kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries, 'deep': <class 'bool'>}) 23番目のメソッド: corr df.corrの受け取れる引数: FullArgSpec(args=['self', 'method', 'min_periods'], varargs=None, varkw=None, defaults=('pearson', 1), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 24番目のメソッド: corrwith df.corrwithの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'drop', 'method'], varargs=None, varkw=None, defaults=(0, False, 'pearson'), kwonlyargs=[], kwonlydefaults=None, annotations={'return': <class 'pandas.core.series.Series'>}) 25番目のメソッド: count df.countの受け取れる引数: FullArgSpec(args=['self', 'axis', 'level', 'numeric_only'], varargs=None, varkw=None, defaults=(0, None, False), kwonlyargs=[], kwonlydefaults=None, annotations={}) 26番目のメソッド: cov df.covの受け取れる引数: FullArgSpec(args=['self', 'min_periods', 'ddof'], varargs=None, varkw=None, defaults=(None, 1), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame', 'min_periods': typing.Union[int, NoneType], 'ddof': typing.Union[int, NoneType]}) 27番目のメソッド: cummax df.cummaxの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna'], varargs='args', varkw='kwargs', defaults=(None, True), kwonlyargs=[], kwonlydefaults=None, annotations={}) 28番目のメソッド: cummin df.cumminの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna'], varargs='args', varkw='kwargs', defaults=(None, True), kwonlyargs=[], kwonlydefaults=None, annotations={}) 29番目のメソッド: cumprod df.cumprodの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna'], varargs='args', varkw='kwargs', defaults=(None, True), kwonlyargs=[], kwonlydefaults=None, annotations={}) 30番目のメソッド: cumsum df.cumsumの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna'], varargs='args', varkw='kwargs', defaults=(None, True), kwonlyargs=[], kwonlydefaults=None, annotations={}) 31番目のメソッド: describe df.describeの受け取れる引数: FullArgSpec(args=['self', 'percentiles', 'include', 'exclude', 'datetime_is_numeric'], varargs=None, varkw=None, defaults=(None, None, None, False), kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries}) 32番目のメソッド: diff df.diffの受け取れる引数: FullArgSpec(args=['self', 'periods', 'axis'], varargs=None, varkw=None, defaults=(1, 0), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame', 'periods': <class 'int'>, 'axis': typing.Union[str, int]}) 33番目のメソッド: div df.divの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 34番目のメソッド: divide df.divideの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 35番目のメソッド: dot df.dotの受け取れる引数: FullArgSpec(args=['self', 'other'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={}) 36番目のメソッド: drop df.dropの受け取れる引数: FullArgSpec(args=['self', 'labels', 'axis', 'index', 'columns', 'level', 'inplace', 'errors'], varargs=None, varkw=None, defaults=(None, 0, None, None, None, False, 'raise'), kwonlyargs=[], kwonlydefaults=None, annotations={}) 37番目のメソッド: droplevel df.droplevelの受け取れる引数: FullArgSpec(args=['self', 'level', 'axis'], varargs=None, varkw=None, defaults=(0,), kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries}) 38番目のメソッド: dropna df.dropnaの受け取れる引数: FullArgSpec(args=['self', 'axis', 'how', 'thresh', 'subset', 'inplace'], varargs=None, varkw=None, defaults=(0, 'any', None, None, False), kwonlyargs=[], kwonlydefaults=None, annotations={}) 39番目のメソッド: duplicated df.duplicatedの受け取れる引数: FullArgSpec(args=['self', 'subset', 'keep'], varargs=None, varkw=None, defaults=(None, 'first'), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'Series', 'subset': typing.Union[typing.Hashable, typing.Sequence[typing.Hashable], NoneType], 'keep': typing.Union[str, bool]}) 40番目のメソッド: eq df.eqの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level'], varargs=None, varkw=None, defaults=('columns', None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 41番目のメソッド: equals df.equalsの受け取れる引数: FullArgSpec(args=['self', 'other'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={}) 42番目のメソッド: eval df.evalの受け取れる引数: FullArgSpec(args=['self', 'expr', 'inplace'], varargs=None, varkw='kwargs', defaults=(False,), kwonlyargs=[], kwonlydefaults=None, annotations={}) 43番目のメソッド: ewm df.ewmの受け取れる引数: FullArgSpec(args=['self', 'com', 'span', 'halflife', 'alpha', 'min_periods', 'adjust', 'ignore_na', 'axis', 'times'], varargs=None, varkw=None, defaults=(None, None, None, None, 0, True, False, 0, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 44番目のメソッド: expanding df.expandingの受け取れる引数: FullArgSpec(args=['self', 'min_periods', 'center', 'axis'], varargs=None, varkw=None, defaults=(1, None, 0), kwonlyargs=[], kwonlydefaults=None, annotations={}) 45番目のメソッド: explode df.explodeの受け取れる引数: FullArgSpec(args=['self', 'column', 'ignore_index'], varargs=None, varkw=None, defaults=(False,), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame', 'column': typing.Union[str, typing.Tuple], 'ignore_index': <class 'bool'>}) 46番目のメソッド: ffill df.ffillの受け取れる引数: FullArgSpec(args=['self', 'axis', 'inplace', 'limit', 'downcast'], varargs=None, varkw=None, defaults=(None, False, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': typing.Union[~FrameOrSeries, NoneType], 'self': ~FrameOrSeries, 'inplace': <class 'bool'>}) 47番目のメソッド: fillna df.fillnaの受け取れる引数: FullArgSpec(args=['self', 'value', 'method', 'axis', 'inplace', 'limit', 'downcast'], varargs=None, varkw=None, defaults=(None, None, None, False, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': typing.Union[ForwardRef('DataFrame'), NoneType]}) 48番目のメソッド: filter df.filterの受け取れる引数: FullArgSpec(args=['self', 'items', 'like', 'regex', 'axis'], varargs=None, varkw=None, defaults=(None, None, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries, 'like': typing.Union[str, NoneType], 'regex': typing.Union[str, NoneType]}) 49番目のメソッド: first df.firstの受け取れる引数: FullArgSpec(args=['self', 'offset'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries}) 50番目のメソッド: floordiv df.floordivの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 51番目のメソッド: ge df.geの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level'], varargs=None, varkw=None, defaults=('columns', None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 52番目のメソッド: get df.getの受け取れる引数: FullArgSpec(args=['self', 'key', 'default'], varargs=None, varkw=None, defaults=(None,), kwonlyargs=[], kwonlydefaults=None, annotations={}) 53番目のメソッド: groupby df.groupbyの受け取れる引数: FullArgSpec(args=['self', 'by', 'axis', 'level', 'as_index', 'sort', 'group_keys', 'squeeze', 'observed', 'dropna'], varargs=None, varkw=None, defaults=(None, 0, None, True, True, True, <object object at 0x10f5df5c0>, False, True), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrameGroupBy', 'as_index': <class 'bool'>, 'sort': <class 'bool'>, 'group_keys': <class 'bool'>, 'squeeze': <class 'bool'>, 'observed': <class 'bool'>, 'dropna': <class 'bool'>}) 54番目のメソッド: gt df.gtの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level'], varargs=None, varkw=None, defaults=('columns', None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 55番目のメソッド: head df.headの受け取れる引数: FullArgSpec(args=['self', 'n'], varargs=None, varkw=None, defaults=(5,), kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries, 'n': <class 'int'>}) 56番目のメソッド: hist df.histの受け取れる引数: FullArgSpec(args=['data', 'column', 'by', 'grid', 'xlabelsize', 'xrot', 'ylabelsize', 'yrot', 'ax', 'sharex', 'sharey', 'figsize', 'layout', 'bins', 'backend', 'legend'], varargs=None, varkw='kwargs', defaults=(None, None, True, None, None, None, None, None, False, False, None, None, 10, None, False), kwonlyargs=[], kwonlydefaults=None, annotations={'data': 'DataFrame', 'column': typing.Union[typing.Hashable, NoneType, typing.Sequence[typing.Union[typing.Hashable, NoneType]]], 'grid': <class 'bool'>, 'xlabelsize': typing.Union[int, NoneType], 'xrot': typing.Union[float, NoneType], 'ylabelsize': typing.Union[int, NoneType], 'yrot': typing.Union[float, NoneType], 'sharex': <class 'bool'>, 'sharey': <class 'bool'>, 'figsize': typing.Union[typing.Tuple[int, int], NoneType], 'layout': typing.Union[typing.Tuple[int, int], NoneType], 'bins': typing.Union[int, typing.Sequence[int]], 'backend': typing.Union[str, NoneType], 'legend': <class 'bool'>}) 57番目のメソッド: idxmax df.idxmaxの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna'], varargs=None, varkw=None, defaults=(0, True), kwonlyargs=[], kwonlydefaults=None, annotations={'return': <class 'pandas.core.series.Series'>}) 58番目のメソッド: idxmin df.idxminの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna'], varargs=None, varkw=None, defaults=(0, True), kwonlyargs=[], kwonlydefaults=None, annotations={'return': <class 'pandas.core.series.Series'>}) 59番目のメソッド: iloc df.ilocの受け取れる引数: FullArgSpec(args=['self', 'axis'], varargs=None, varkw=None, defaults=(None,), kwonlyargs=[], kwonlydefaults=None, annotations={}) 60番目のメソッド: info df.infoの受け取れる引数: FullArgSpec(args=['self', 'verbose', 'buf', 'max_cols', 'memory_usage', 'null_counts'], varargs=None, varkw=None, defaults=(None, None, None, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': None, 'verbose': typing.Union[bool, NoneType], 'buf': typing.Union[typing.IO[str], NoneType], 'max_cols': typing.Union[int, NoneType], 'memory_usage': typing.Union[bool, str, NoneType], 'null_counts': typing.Union[bool, NoneType]}) 61番目のメソッド: insert df.insertの受け取れる引数: FullArgSpec(args=['self', 'loc', 'column', 'value', 'allow_duplicates'], varargs=None, varkw=None, defaults=(False,), kwonlyargs=[], kwonlydefaults=None, annotations={'return': None}) 62番目のメソッド: interpolate df.interpolateの受け取れる引数: FullArgSpec(args=['self', 'method', 'axis', 'limit', 'inplace', 'limit_direction', 'limit_area', 'downcast'], varargs=None, varkw='kwargs', defaults=('linear', 0, None, False, None, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': typing.Union[~FrameOrSeries, NoneType], 'self': ~FrameOrSeries, 'method': <class 'str'>, 'axis': typing.Union[str, int], 'limit': typing.Union[int, NoneType], 'inplace': <class 'bool'>, 'limit_direction': typing.Union[str, NoneType], 'limit_area': typing.Union[str, NoneType], 'downcast': typing.Union[str, NoneType]}) 63番目のメソッド: isin df.isinの受け取れる引数: FullArgSpec(args=['self', 'values'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 64番目のメソッド: isna df.isnaの受け取れる引数: FullArgSpec(args=['self'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 65番目のメソッド: isnull df.isnullの受け取れる引数: FullArgSpec(args=['self'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 66番目のメソッド: items df.itemsの受け取れる引数: FullArgSpec(args=['self'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': typing.Iterable[typing.Tuple[typing.Union[typing.Hashable, NoneType], pandas.core.series.Series]]}) 67番目のメソッド: iteritems df.iteritemsの受け取れる引数: FullArgSpec(args=['self'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': typing.Iterable[typing.Tuple[typing.Union[typing.Hashable, NoneType], pandas.core.series.Series]]}) 68番目のメソッド: iterrows df.iterrowsの受け取れる引数: FullArgSpec(args=['self'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': typing.Iterable[typing.Tuple[typing.Union[typing.Hashable, NoneType], pandas.core.series.Series]]}) 69番目のメソッド: itertuples df.itertuplesの受け取れる引数: FullArgSpec(args=['self', 'index', 'name'], varargs=None, varkw=None, defaults=(True, 'Pandas'), kwonlyargs=[], kwonlydefaults=None, annotations={}) 70番目のメソッド: join df.joinの受け取れる引数: FullArgSpec(args=['self', 'other', 'on', 'how', 'lsuffix', 'rsuffix', 'sort'], varargs=None, varkw=None, defaults=(None, 'left', '', '', False), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 71番目のメソッド: keys df.keysの受け取れる引数: FullArgSpec(args=['self'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={}) 72番目のメソッド: kurt df.kurtの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna', 'level', 'numeric_only'], varargs=None, varkw='kwargs', defaults=(None, None, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 73番目のメソッド: kurtosis df.kurtosisの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna', 'level', 'numeric_only'], varargs=None, varkw='kwargs', defaults=(None, None, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 74番目のメソッド: last df.lastの受け取れる引数: FullArgSpec(args=['self', 'offset'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries}) 75番目のメソッド: le df.leの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level'], varargs=None, varkw=None, defaults=('columns', None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 76番目のメソッド: loc df.locの受け取れる引数: FullArgSpec(args=['self', 'axis'], varargs=None, varkw=None, defaults=(None,), kwonlyargs=[], kwonlydefaults=None, annotations={}) 77番目のメソッド: lookup df.lookupの受け取れる引数: FullArgSpec(args=['self', 'row_labels', 'col_labels'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': <class 'numpy.ndarray'>}) 78番目のメソッド: lt df.ltの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level'], varargs=None, varkw=None, defaults=('columns', None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 79番目のメソッド: mad df.madの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna', 'level'], varargs=None, varkw=None, defaults=(None, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 80番目のメソッド: mask df.maskの受け取れる引数: FullArgSpec(args=['self', 'cond', 'other', 'inplace', 'axis', 'level', 'errors', 'try_cast'], varargs=None, varkw=None, defaults=(nan, False, None, None, 'raise', False), kwonlyargs=[], kwonlydefaults=None, annotations={}) 81番目のメソッド: max df.maxの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna', 'level', 'numeric_only'], varargs=None, varkw='kwargs', defaults=(None, None, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 82番目のメソッド: mean df.meanの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna', 'level', 'numeric_only'], varargs=None, varkw='kwargs', defaults=(None, None, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 83番目のメソッド: median df.medianの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna', 'level', 'numeric_only'], varargs=None, varkw='kwargs', defaults=(None, None, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 84番目のメソッド: melt df.meltの受け取れる引数: FullArgSpec(args=['self', 'id_vars', 'value_vars', 'var_name', 'value_name', 'col_level', 'ignore_index'], varargs=None, varkw=None, defaults=(None, None, None, 'value', None, True), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 85番目のメソッド: merge df.mergeの受け取れる引数: FullArgSpec(args=['self', 'right', 'how', 'on', 'left_on', 'right_on', 'left_index', 'right_index', 'sort', 'suffixes', 'copy', 'indicator', 'validate'], varargs=None, varkw=None, defaults=('inner', None, None, None, False, False, False, ('_x', '_y'), True, False, None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 86番目のメソッド: min df.minの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna', 'level', 'numeric_only'], varargs=None, varkw='kwargs', defaults=(None, None, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 87番目のメソッド: mod df.modの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 88番目のメソッド: mode df.modeの受け取れる引数: FullArgSpec(args=['self', 'axis', 'numeric_only', 'dropna'], varargs=None, varkw=None, defaults=(0, False, True), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 89番目のメソッド: mul df.mulの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 90番目のメソッド: multiply df.multiplyの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 91番目のメソッド: ne df.neの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level'], varargs=None, varkw=None, defaults=('columns', None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 92番目のメソッド: nlargest df.nlargestの受け取れる引数: FullArgSpec(args=['self', 'n', 'columns', 'keep'], varargs=None, varkw=None, defaults=('first',), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 93番目のメソッド: notna df.notnaの受け取れる引数: FullArgSpec(args=['self'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 94番目のメソッド: notnull df.notnullの受け取れる引数: FullArgSpec(args=['self'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 95番目のメソッド: nsmallest df.nsmallestの受け取れる引数: FullArgSpec(args=['self', 'n', 'columns', 'keep'], varargs=None, varkw=None, defaults=('first',), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 96番目のメソッド: nunique df.nuniqueの受け取れる引数: FullArgSpec(args=['self', 'axis', 'dropna'], varargs=None, varkw=None, defaults=(0, True), kwonlyargs=[], kwonlydefaults=None, annotations={'return': <class 'pandas.core.series.Series'>}) 97番目のメソッド: pad df.padの受け取れる引数: FullArgSpec(args=['self', 'axis', 'inplace', 'limit', 'downcast'], varargs=None, varkw=None, defaults=(None, False, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': typing.Union[~FrameOrSeries, NoneType], 'self': ~FrameOrSeries, 'inplace': <class 'bool'>}) 98番目のメソッド: pipe df.pipeの受け取れる引数: FullArgSpec(args=['self', 'func'], varargs='args', varkw='kwargs', defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={}) 99番目のメソッド: pivot df.pivotの受け取れる引数: FullArgSpec(args=['self', 'index', 'columns', 'values'], varargs=None, varkw=None, defaults=(None, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 100番目のメソッド: plot df.plotの受け取れる引数: FullArgSpec(args=['self'], varargs='args', varkw='kwargs', defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={}) 101番目のメソッド: pop df.popの受け取れる引数: FullArgSpec(args=['self', 'item'], varargs=None, varkw=None, defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': <class 'pandas.core.series.Series'>, 'item': typing.Union[typing.Hashable, NoneType]}) 102番目のメソッド: pow df.powの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 103番目のメソッド: prod df.prodの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna', 'level', 'numeric_only', 'min_count'], varargs=None, varkw='kwargs', defaults=(None, None, None, None, 0), kwonlyargs=[], kwonlydefaults=None, annotations={}) 104番目のメソッド: product df.productの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna', 'level', 'numeric_only', 'min_count'], varargs=None, varkw='kwargs', defaults=(None, None, None, None, 0), kwonlyargs=[], kwonlydefaults=None, annotations={}) 105番目のメソッド: quantile df.quantileの受け取れる引数: FullArgSpec(args=['self', 'q', 'axis', 'numeric_only', 'interpolation'], varargs=None, varkw=None, defaults=(0.5, 0, True, 'linear'), kwonlyargs=[], kwonlydefaults=None, annotations={}) 106番目のメソッド: query df.queryの受け取れる引数: FullArgSpec(args=['self', 'expr', 'inplace'], varargs=None, varkw='kwargs', defaults=(False,), kwonlyargs=[], kwonlydefaults=None, annotations={}) 107番目のメソッド: radd df.raddの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 108番目のメソッド: rank df.rankの受け取れる引数: FullArgSpec(args=['self', 'axis', 'method', 'numeric_only', 'na_option', 'ascending', 'pct'], varargs=None, varkw=None, defaults=(0, 'average', None, 'keep', True, False), kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries, 'method': <class 'str'>, 'numeric_only': typing.Union[bool, NoneType], 'na_option': <class 'str'>, 'ascending': <class 'bool'>, 'pct': <class 'bool'>}) 109番目のメソッド: rdiv df.rdivの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 110番目のメソッド: reindex df.reindexの受け取れる引数: FullArgSpec(args=[], varargs='args', varkw='kwargs', defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 111番目のメソッド: rename df.renameの受け取れる引数: FullArgSpec(args=[], varargs='args', varkw='kwargs', defaults=None, kwonlyargs=[], kwonlydefaults=None, annotations={'return': typing.Union[ForwardRef('DataFrame'), NoneType]}) 112番目のメソッド: replace df.replaceの受け取れる引数: FullArgSpec(args=['self', 'to_replace', 'value', 'inplace', 'limit', 'regex', 'method'], varargs=None, varkw=None, defaults=(None, None, False, None, False, 'pad'), kwonlyargs=[], kwonlydefaults=None, annotations={}) 113番目のメソッド: resample df.resampleの受け取れる引数: FullArgSpec(args=['self', 'rule', 'axis', 'closed', 'label', 'convention', 'kind', 'loffset', 'base', 'on', 'level', 'origin', 'offset'], varargs=None, varkw=None, defaults=(0, None, None, 'start', None, None, None, None, None, 'start_day', None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'Resampler', 'closed': typing.Union[str, NoneType], 'label': typing.Union[str, NoneType], 'convention': <class 'str'>, 'kind': typing.Union[str, NoneType], 'base': typing.Union[int, NoneType], 'origin': typing.Union[str, ForwardRef('Timestamp'), datetime.datetime, numpy.datetime64, int, numpy.int64, float], 'offset': typing.Union[ForwardRef('Timedelta'), datetime.timedelta, numpy.timedelta64, int, numpy.int64, float, str, NoneType]}) 114番目のメソッド: rfloordiv df.rfloordivの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 115番目のメソッド: rmod df.rmodの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 116番目のメソッド: rmul df.rmulの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 117番目のメソッド: rolling df.rollingの受け取れる引数: FullArgSpec(args=['self', 'window', 'min_periods', 'center', 'win_type', 'on', 'axis', 'closed'], varargs=None, varkw=None, defaults=(None, False, None, None, 0, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 118番目のメソッド: round df.roundの受け取れる引数: FullArgSpec(args=['self', 'decimals'], varargs='args', varkw='kwargs', defaults=(0,), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 119番目のメソッド: rpow df.rpowの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 120番目のメソッド: rsub df.rsubの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 121番目のメソッド: rtruediv df.rtruedivの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 122番目のメソッド: sample df.sampleの受け取れる引数: FullArgSpec(args=['self', 'n', 'frac', 'replace', 'weights', 'random_state', 'axis'], varargs=None, varkw=None, defaults=(None, None, False, None, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries}) 123番目のメソッド: sem df.semの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna', 'level', 'ddof', 'numeric_only'], varargs=None, varkw='kwargs', defaults=(None, None, None, 1, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 124番目のメソッド: shift df.shiftの受け取れる引数: FullArgSpec(args=['self', 'periods', 'freq', 'axis', 'fill_value'], varargs=None, varkw=None, defaults=(1, None, 0, None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 125番目のメソッド: skew df.skewの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna', 'level', 'numeric_only'], varargs=None, varkw='kwargs', defaults=(None, None, None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 126番目のメソッド: squeeze df.squeezeの受け取れる引数: FullArgSpec(args=['self', 'axis'], varargs=None, varkw=None, defaults=(None,), kwonlyargs=[], kwonlydefaults=None, annotations={}) 127番目のメソッド: stack df.stackの受け取れる引数: FullArgSpec(args=['self', 'level', 'dropna'], varargs=None, varkw=None, defaults=(-1, True), kwonlyargs=[], kwonlydefaults=None, annotations={}) 128番目のメソッド: std df.stdの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna', 'level', 'ddof', 'numeric_only'], varargs=None, varkw='kwargs', defaults=(None, None, None, 1, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 129番目のメソッド: sub df.subの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 130番目のメソッド: subtract df.subtractの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 131番目のメソッド: sum df.sumの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna', 'level', 'numeric_only', 'min_count'], varargs=None, varkw='kwargs', defaults=(None, None, None, None, 0), kwonlyargs=[], kwonlydefaults=None, annotations={}) 132番目のメソッド: swapaxes df.swapaxesの受け取れる引数: FullArgSpec(args=['self', 'axis1', 'axis2', 'copy'], varargs=None, varkw=None, defaults=(True,), kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries}) 133番目のメソッド: swaplevel df.swaplevelの受け取れる引数: FullArgSpec(args=['self', 'i', 'j', 'axis'], varargs=None, varkw=None, defaults=(-2, -1, 0), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 134番目のメソッド: tail df.tailの受け取れる引数: FullArgSpec(args=['self', 'n'], varargs=None, varkw=None, defaults=(5,), kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries, 'n': <class 'int'>}) 135番目のメソッド: take df.takeの受け取れる引数: FullArgSpec(args=['self', 'indices', 'axis', 'is_copy'], varargs=None, varkw='kwargs', defaults=(0, None), kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries, 'is_copy': typing.Union[bool, NoneType]}) 136番目のメソッド: transform df.transformの受け取れる引数: FullArgSpec(args=['self', 'func', 'axis'], varargs='args', varkw='kwargs', defaults=(0,), kwonlyargs=[], kwonlydefaults=None, annotations={'return': 'DataFrame'}) 137番目のメソッド: transpose df.transposeの受け取れる引数: FullArgSpec(args=['self'], varargs='args', varkw=None, defaults=None, kwonlyargs=['copy'], kwonlydefaults={'copy': False}, annotations={'return': 'DataFrame', 'copy': <class 'bool'>}) 138番目のメソッド: truediv df.truedivの受け取れる引数: FullArgSpec(args=['self', 'other', 'axis', 'level', 'fill_value'], varargs=None, varkw=None, defaults=('columns', None, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 139番目のメソッド: truncate df.truncateの受け取れる引数: FullArgSpec(args=['self', 'before', 'after', 'axis', 'copy'], varargs=None, varkw=None, defaults=(None, None, None, True), kwonlyargs=[], kwonlydefaults=None, annotations={'return': ~FrameOrSeries, 'self': ~FrameOrSeries, 'copy': <class 'bool'>}) 140番目のメソッド: unstack df.unstackの受け取れる引数: FullArgSpec(args=['self', 'level', 'fill_value'], varargs=None, varkw=None, defaults=(-1, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 141番目のメソッド: update df.updateの受け取れる引数: FullArgSpec(args=['self', 'other', 'join', 'overwrite', 'filter_func', 'errors'], varargs=None, varkw=None, defaults=('left', True, None, 'ignore'), kwonlyargs=[], kwonlydefaults=None, annotations={'return': None}) 142番目のメソッド: var df.varの受け取れる引数: FullArgSpec(args=['self', 'axis', 'skipna', 'level', 'ddof', 'numeric_only'], varargs=None, varkw='kwargs', defaults=(None, None, None, 1, None), kwonlyargs=[], kwonlydefaults=None, annotations={}) 143番目のメソッド: where df.whereの受け取れる引数: FullArgSpec(args=['self', 'cond', 'other', 'inplace', 'axis', 'level', 'errors', 'try_cast'], varargs=None, varkw=None, defaults=(nan, False, None, None, 'raise', False), kwonlyargs=[], kwonlydefaults=None, annotations={}) 144番目のメソッド: xs df.xsの受け取れる引数: FullArgSpec(args=['self', 'key', 'axis', 'level', 'drop_level'], varargs=None, varkw=None, defaults=(0, None, True), kwonlyargs=[], kwonlydefaults=None, annotations={'drop_level': <class 'bool'>})結構知らないのある。

この記事が役に立ったと思ったらLGTMお願いいたします

- 投稿日:2020-11-25T22:48:29+09:00

gdstkでPython最速のGDSII layout制作環境を作る

はじめに

この記事は、過去記事”PythonでGDSII formatを扱う”および”gdspyを使って、PythonではじめてのGDSIIファイルを作る”の続きである。これらの記事では、Python上でGDSII layoutを扱うためのライブラリ"gdspy"について説明してきたが、これはPythonネイティブで動作するため遅すぎた。そのため作者である@heitzmannはver.1.6系を最後にgdspyの継続をあきらめ、新規プロジェクト"gdstk"(GDSII Tool Kit)に現在注力している。gdstkは、C++で書かれたGDSIIファイルI/Oと、そのPythonラッパーで構成される。したがって我々ユーザの立場からは、Pythonの高い可読性と機能性とを維持したまま、C++に由来する高速性を発揮してGDSII layoutファイルを取り扱うことができる1。高速化の寄与は驚異的で、gdspyその他PythonによるGDSII関係ライブラリに比べて10倍~20倍は当たり前である2。本稿執筆現在、ver0.2.0までが公開されている。本記事では、まずgdstkを利用するための環境構築について述べ、次にgdstkを利用した簡単なGDSIIファイル作成について述べる。

GDSTKの環境構築

gdstkはconda-forgeおよびpipパッケージに収録されているため、そのインストールはとっても簡単3である。

> conda install -c conda-forge gdstk

または

> pip install gdstk

でインストールできる。そのほか、Anaconda3などを用いれば、GUIで簡単にインストールできる。Anaconda等でgdstk用仮想環境を作成の上インストールすることをお勧めする。GDSTKの歩き方

更新など最新情報はGitHubで、APIリファレンス含む完全なドキュメントはこちらで公開されている。英語力に自信のある向きはこんな記事読んでないでこれら公式を読むべきである。GitHubでウォッチしてメーリングリストを購読すると、細かいノウハウに関する情報共有ができるのでお勧めである。またプロジェクト継続のためぜひ作者である@heitzmannに寄付をお願いしたい。

GDSTKではじめてのGDSIIファイルを出力する

次のコードを実行してみよう。

first.pyimport gdstk lib = gdstk.Library() #特に指定しなければ単位はum topcell = lib.new_cell("Top") #Topセルを作成 subcell = lib.new_cell("subcell") #サブセルを作成 box = gdstk.rectangle((0,0), (1,2)) #左下(0,0),右上(1,2)の四角形を作成 subcell.add(box) #四角形をサブセルに追加 ref = gdstk.Reference(subcell, origin=(0,0), columns =3, rows =2, spacing = (5,5)) #サブセルへの配列リファレンスを原点(0,0)に挿入。3行2列で、間隔は(5,5) topcell.add(ref) #サブセルへのリファレンスをTopセルに挿入。 text = gdstk.text('First GDS',2, (0,10)) #高さ2のテキストを位置(0,10)に挿入。 topcell.add(*text) #gdstk.textは1文字ずつのPolygonのリストを返すので、*textでリストをunpackしてadd()に渡す。 lib.write_gds('output.gds') #gdsファイル出力 topcell.write_svg('output.svg') #svgファイル出力

output.gdsとoutput.svgの2つのファイルが出力される。output.svgの中身はこんな感じ。

output.gdsは、KLayout等で閲覧できる。OASIS形式でファイルを出力する

OASIS形式はGDSIIの後継となるレイアウトフォーマットである。非矩形配列、Parametric cell、ファイル内部でのzlib圧縮などをサポートしているためGDSIIに比べファイルサイズを1/10程度にできる。KLayoutをインストールしていれば、それと同じフォルダにstrm2oas.exeが入っているはずである4。これはコマンドラインでKLayoutを呼び出してGDSIIをOASIS形式に変換してくれる。下記をfirst.pyに追記して実行すればOASISファイルを出力できる。これはWindowsの場合であるが、strm2oasのパスは適宜読み替えてほしい。

first.pyimport subprocess del lib #ファイルを出力したのでメモリ確保のためgdsライブラリを破棄する。 subprocess.call('C:\\Users\\<username>\\AppData\\Roaming\\KLayout\\strm2oas.exe output.gds output.oas')

- 投稿日:2020-11-25T22:46:48+09:00

【VSCode tips】VSCode の Python Extension のエラーを修正する 【#3】

現象

Windows 10 にて Visual Studio CodeのPython拡張機能をインストール・有効化すると、

C:\Users\ユーザー名\AppData\Local\Microsoft\WindowsApps\python3.exeというログが出力される。原因

Windows 10 の機能である

アプリ実行エイリアスにて、上記パスを参照しているが、python3.exeは存在しない(実行ファイルでない)ため、エラーが出力されている。対処

アプリ実行エイリアスから python を参照している、該当すエントリーを削除する- Visual Studio Codeを再起動する

- 投稿日:2020-11-25T22:35:13+09:00

Flaskのrequestsモジュールについて、すべてのメソッドを実行してしっかり理解する

PythonのFlaskでweb APIを作成することがあるのですが、クエリパラメータの読み込みなどちゃんと理解せずに使ってしまっているので、ここでは、http://127.0.0.1:5000 というURLをFlaskで立てて、そこにPOST通信とGET通信を試みた際の挙動について、requetstsモジュールのすべてのメソッドを実行して調べます。

方法

検証用のflaskの関数とcurlコマンドについて説明します。

Flaskの関数

URLが叩かれたときのrequestモジュールをすべて実行するためのFlaskの関数はこちらです。

main.py# coding: utf-8 from flask import Flask, request app = Flask(__name__) @app.route("/", methods=["GET", "POST"]) def hello(): request_methods = dir(request) print(len(dir(request)),dir(request)) for i,method in enumerate(request_methods): print("%s番目のメソッド:\n %s"%(i+1,method)) exec("print(' request.'+method+'の実行結果:',request.%s)"%(method)) print("") return "Hello World!" if __name__ == "__main__": app.run()Pythonでは、dir()ですべてのメソッドを非再帰的ですが求められますので、これをrequest_methods という変数にリスト形式で保存したあと、文字列をプログラムに変換するexecコマンドを使ってループの中で実行しています。

curlコマンドについて

この関数で立てたURLに対してcurlでGet通信とPost通信を行います。

curl -H 'Host:some_destination.com.' -H 'Authorization:something' -X GET "http://127.0.0.1:5000?arg1=myarg1&arg2=myarg2" --insecureGet通信の場合、基本的には、 http://127.0.0.1:5000?arg1=myarg1&arg2=myarg2 と言う形でクエリパラメータを付与した場合の挙動を調べるようにしています。

curl -X POST -H 'Host:some_destination.com.' -H 'Authorization:something' -F 'image=@./na18_1920x1080_221804.jpg' -F "arg1=myarg1" -F "arg2=myarg2" http://127.0.0.1:5000/ --insecurePost通信の場合、クエリパラメータを同様に付与することに加えて、HTMLのformから画像をsubmitした場合のrequestモジュールの挙動を調べます。今回は、curlコマンドを打つターミナルの場所にna18_1920x1080_221804.jpgと言う画像ファイルを置いて、それをformからSubmitしています。

以下、Get通信とPost通信をした結果ですが、Requestsモジュールは下記の116個のメソッドも持つため結構長くなります。ご了承ください。

['__class__', '__delattr__', '__dict__', '__dir__', '__doc__', '__enter__', '__eq__', '__exit__', '__format__', '__ge__', '__getattribute__', '__gt__', '__hash__', '__init__', '__init_subclass__', '__le__', '__lt__', '__module__', '__ne__', '__new__', '__reduce__', '__reduce_ex__', '__repr__', '__setattr__', '__sizeof__', '__str__', '__subclasshook__', '__weakref__', '_cached_json', '_get_data_for_json', '_get_file_stream', '_get_stream_for_parsing', '_load_form_data', '_parse_content_type', 'accept_charsets', 'accept_encodings', 'accept_languages', 'accept_mimetypes', 'access_control_request_headers', 'access_control_request_method', 'access_route', 'application', 'args', 'authorization', 'base_url', 'blueprint', 'cache_control', 'charset', 'close', 'content_encoding', 'content_length', 'content_md5', 'content_type', 'cookies', 'data', 'date', 'dict_storage_class', 'disable_data_descriptor', 'encoding_errors', 'endpoint', 'environ', 'files', 'form', 'form_data_parser_class', 'from_values', 'full_path', 'get_data', 'get_json', 'headers', 'host', 'host_url', 'if_match', 'if_modified_since', 'if_none_match', 'if_range', 'if_unmodified_since', 'input_stream', 'is_json', 'is_multiprocess', 'is_multithread', 'is_run_once', 'is_secure', 'json', 'json_module', 'list_storage_class', 'make_form_data_parser', 'max_content_length', 'max_form_memory_size', 'max_forwards', 'method', 'mimetype', 'mimetype_params', 'on_json_loading_failed', 'origin', 'parameter_storage_class', 'path', 'pragma', 'query_string', 'range', 'referrer', 'remote_addr', 'remote_user', 'routing_exception', 'scheme', 'script_root', 'shallow', 'stream', 'trusted_hosts', 'url', 'url_charset', 'url_root', 'url_rule', 'user_agent', 'values', 'view_args', 'want_form_data_parsed']結果

Get通信の場合

基本的には43番目のargs、45番目のbase_url66番目のfull_path、68番目のget_json、69番目のheaders,90番目のmethod,98番目のquery_string、109番目のurl,111番目のurl_rootあたりがGet通信では見ておけば良さそうです。