- 投稿日:2020-10-24T23:44:33+09:00

【python】for文エラー

TypeError: 'int' object is not iterable

のエラーが生じたときの対処法for文の使い方

以下のように in の後には範囲を指定する。

for i in range(0:4): print(i) #0 1 2 3上の例では in の後に0から3を指定している。

エラーが出る使い方

以下のように in の後に数字のみを入れるとエラーが起きる。

for i in 4: print(i) #TypeError: 'int' object is not iterable以上の例は in の後に数字が入っているため、for文を何回したらよいかわからないというエラーが出ている。

- 投稿日:2020-10-24T23:32:09+09:00

FastAPI + SQLAlchemy(postgresql)でAPI実装してみた(Dockerやミドルウェア, テストコードなども含む)

アーキテクチャ

python: v3.8.5 postgresql: v12.4 fastapi: v0.60.2 SQLAlchemy: v1.3.18マイグレーションツール

alembic: v1.4.2FastAPIとは

詳細は既にQiitaにチョコチョコ記事あるので割愛します。

ドキュメントが豊富(読みきれてない)で、Swaggerと互換性あるのがとても素晴らしいです。

(パフォーマンスも良いらしいがベンチマーク測ったことないので断言できない、でも多分速い。)

しっかり触ったことのあるフレームワークはDjangoだけなのでミドルウェアやテストコード周り苦労した・・・。

(Djangoはフルスタックフレームワークだからミドルウェアとかあまり気にしたことない)Python3.8.5の仮装環境作成

pyenv, virtualenvが入ってない場合は下記を参考に入れてください。

・Mac

・Windows$ pyenv virtualenv 3.8.5 env_fastapi_sample仮装環境を適用

プロジェクトルートを作成

$ mkdir fastapi_sampleプロジェクトルートにcd

$ cd fastapi_sample仮装環境を適用

$ pyenv local env_fastapi_samplerequirements.txt作成/インストール

$ touch requirements.txtrequirements.txtにfastapiを追記

fastapi_sample/requirements.txtfastapi==0.60.2 uvicorn==0.11.8仮装環境にインストール

$ pip3 install -r requirements.txtエントリーポイント(main.py)を作成して、Swagger-UIを表示してみる

エントリーポイント(main.py)作成

$ touch main.pymain.pyを編集

fastapi_sample/main.pyfrom fastapi import FastAPI app = FastAPI() @app.get("/") async def root(): return {"message": "Hello World"}Swagger-UI表示

$ uvicorn main:app --reloadブラウザから「http://127.0.0.1:8000」にアクセスして

{"message":"Hello World"}が表示されていれば完了です。Docker化

Nginxのリバースプロキシによってアプリケーションをhttpsで公開するようにします。

ベースのdocker-compose.yml

fastapi_sample/docker-compose.ymlversion: '3' services: # Nginxコンテナ nginx: container_name: nginx_fastapi_sample image: nginx:alpine depends_on: - app - db environment: TZ: "Asia/Tokyo" ports: - "80:80" - "443:443" volumes: - ./docker/nginx/conf.d:/etc/nginx/conf.d - ./docker/nginx/ssl:/etc/nginx/ssl # アプリケーションコンテナ app: build: context: . dockerfile: Dockerfile container_name: app_fastapi_sample volumes: - '.:/fastapi_sample/' environment: - LC_ALL=ja_JP.UTF-8 expose: - 8000 depends_on: - db entrypoint: /fastapi_sample/docker/wait-for-it.sh db 5432 postgres postgres db_fastapi_sample command: bash /fastapi_sample/docker/rundevserver.sh restart: always tty: true # DBコンテナ db: image: postgres:12.4-alpine container_name: db_fastapi_sample environment: - POSTGRES_USER=postgres - POSTGRES_PASSWORD=postgres - POSTGRES_DB=db_fastapi_sample - POSTGRES_INITDB_ARGS=--encoding=UTF-8 --locale=C volumes: - db_data:/var/lib/postgresql/data ports: - '5432:5432' volumes: db_data: driver: localNginxコンテナの設定

confファイルを用意する

$ mkdir -p nginx/conf.d $ touch nginx/conf.d/app.conffastapi_sample/docker/nginx/conf.d/app.confupstream backend { server app:8000; # appはdocker-compose.ymlの「app」 } # 80番ポートへのアクセスは443番ポートへのアクセスに強制する server { listen 80; return 301 https://$host$request_uri; } server { listen 443 ssl; ssl_certificate /etc/nginx/ssl/server.crt; ssl_certificate_key /etc/nginx/ssl/server.key; ssl_protocols TLSv1.2 TLSv1.3; location / { proxy_set_header Host $http_host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-Host $http_host; proxy_set_header X-Forwarded-Server $http_host; proxy_set_header X-Forwarded-Server $host; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header X-Forwarded-Proto $scheme; proxy_redirect http:// https://; proxy_pass http://backend; } # ログを出力したい場合はコメントアウト外してください # access_log /var/log/nginx/access.log; # error_log /var/log/nginx/error.log; } server_tokens off;NginxのSSL化に必要なファイルを用意

$ mkdir -p nginx/conf.d nginx/sslOpenSSLを使って秘密鍵(server.key)を生成する

# ディレクトリ移動 $ cd nginx/conf.d # 秘密鍵生成 $ openssl genrsa 2024 > server.key # 確認 $ ls -ll total 8 -rw-r--r-- 1 user staff 1647 10 24 13:23 server.key証明書署名要求(server.csr)を生成

$ openssl req -new -key server.key > server.csr$ openssl req -new -key server.key > server.csr ... .. . Country Name (2 letter code) [AU]:JP # 国を示す2文字のISO略語 State or Province Name (full name) [Some-State]:Tokyo # 会社が置かれている都道府県 Locality Name (eg, city) []:Chiyodaku # 会社が置かれている市区町村 Organization Name (eg, company) [Internet Widgits Pty Ltd]:fabeee # 会社名 Organizational Unit Name (eg, section) []:- # 部署名(ハイフンにしました。) Common Name (e.g. server FQDN or YOUR name) []:localhost(ウェブサーバのFQDN。一応localhostにした) Email Address []: # 未入力でエンター Please enter the following 'extra' attributes to be sent with your certificate request A challenge password []: # 未入力でエンター An optional company name []: # 未入力でエンター ... .. . $ ls -ll total 16 -rw-r--r-- 1 user staff 980 10 24 13:27 server.csr # 証明書署名要求ができた -rw-r--r-- 1 user staff 1647 10 24 13:23 server.keyサーバ証明書(server.crt)を生成

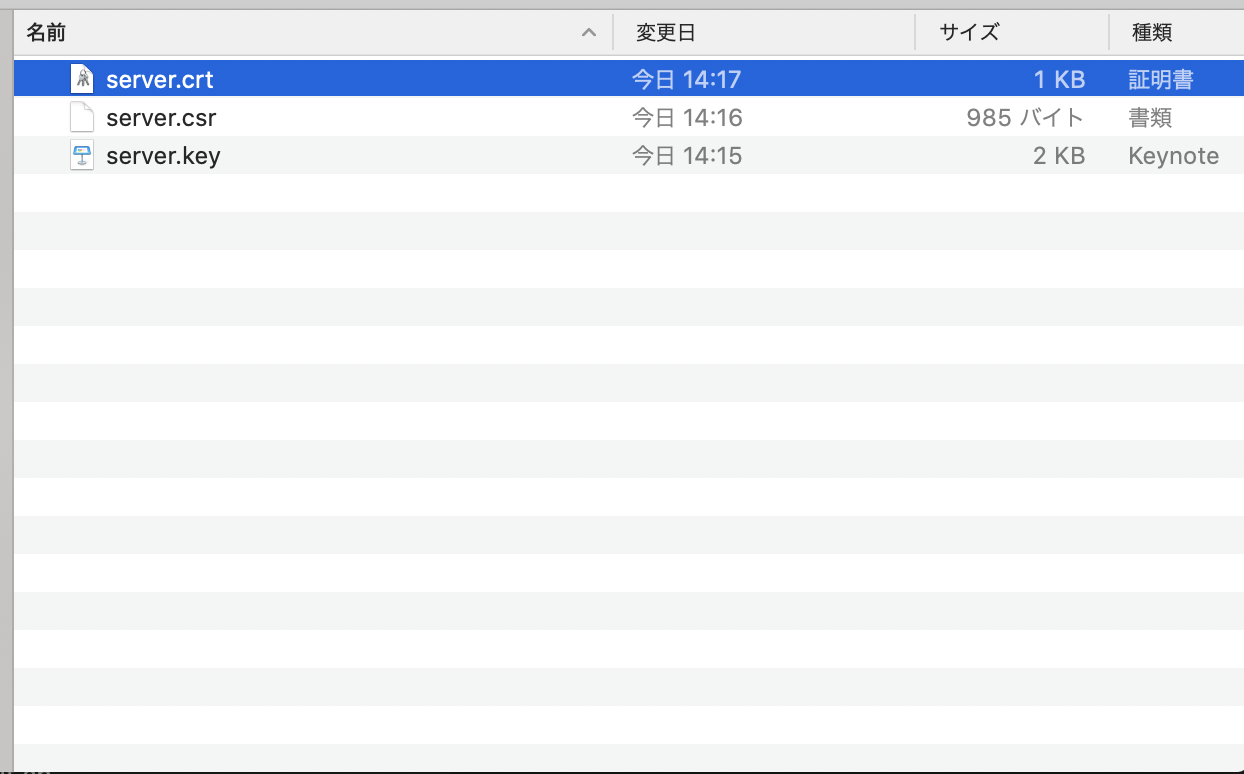

openssl x509 -req -days 3650 -signkey server.key < server.csr > server.crt % ls -ll total 24 -rw-r--r-- 1 tabata staff 1115 10 24 13:40 server.crt # サーバ証明書ができた -rw-r--r-- 1 tabata staff 948 10 24 13:29 server.csr -rw-r--r-- 1 tabata staff 1647 10 24 13:23 server.keyサーバ証明書を信頼する

「この証明書を使用するとき」のプルダウンから「常に信頼する」を選択する

最終的にこうなっていればNginxの設定は完了です

fastapi_sample ├── docker │ └── nginx │ ├── conf.d │ │ └── app.conf │ └── ssl │ ├── server.crt │ ├── server.csr │ └── server.key ├── docker-compose.yml ├── main.py └── requirements.txtapp(FastAPI)コンテナの設定

Dockerfile

イメージはubuntu20.04です。

・pyenvでコンテナ内のpythonバージョンをv3.8.5にしている

・apt installで必要なモジュールをインストール(不要なものは削ってもらって構いません)

・pip3 install -r requirements.txtでpythonモジュールをコンテナ内にインストールFROM ubuntu:20.04 ENV DEBIAN_FRONTEND=noninteractive ENV HOME /root ENV PYTHONPATH /fastapi_sample/ ENV PYTHON_VERSION 3.8.5 ENV PYTHON_ROOT $HOME/local/python-$PYTHON_VERSION ENV PATH $PYTHON_ROOT/bin:$PATH ENV PYENV_ROOT $HOME/.pyenv RUN mkdir /fastapi_sample \ && rm -rf /var/lib/apt/lists/* RUN apt update && apt install -y git curl locales python3-pip python3-dev python3-passlib python3-jwt \ libssl-dev libffi-dev zlib1g-dev libpq-dev postgresql RUN echo "ja_JP UTF-8" > /etc/locale.gen \ && locale-gen RUN git clone https://github.com/pyenv/pyenv.git $PYENV_ROOT \ && $PYENV_ROOT/plugins/python-build/install.sh \ && /usr/local/bin/python-build -v $PYTHON_VERSION $PYTHON_ROOT WORKDIR /fastapi_sample ADD . /fastapi_sample/ RUN LC_ALL=ja_JP.UTF-8 \ && pip3 install -r requirements.txtwait-for.it.sh

データベースが立ち上がるのを待ってからappコンテナを起動するようにするためのシェルスクリプトです。

docker-componseに記載しているdepends_onでコンテナの起動順は制御できますが、

データベースが立ち上がっていない場合、appコンテナでエラーが発生することがあります。

(appコンテナ起動時にDB操作をするようなコマンドを実行しようとした場合、データベースが立ち上がっていないためにエラー、とか)fastapi_sample/docker/wait-for-it.sh#!/bin/sh set -e # 引数はdocker-compose.ymlで指定している。 # app: # ... # .. # . # entrypoint: /fastapi_sample/docker/wait-for-it.sh db 5432 postgres postgres db_fastapi_sample # ココ # ... host="$1" shift port="$1" shift user="$1" shift password="$1" shift database="$1" shift cmd="$@" echo "Waiting for postgresql" until pg_isready -h"$host" -U"$user" -p"$port" -d"$database" do echo -n "." sleep 1 done >&2 echo "PostgreSQL is up - executing command" exec $cmdrundevserver.sh

uvicornを起動してアプリケーションを起動するためのシェルスクリプトファイルです。

・docker-compose up時に毎回requirements.txtのモジュールを読み込む

・uvicornでアプリケーションを起動する

・--reloadでホットリロード(pythonファイルを変更すると即反映してくれる)

・--portを8000から変える場合はnginxのapp.conf内の8000も変える必要があるpip3 install -r requirements.txt uvicorn main:app\ --reload\ --port 8000\ --host 0.0.0.0\ --log-level debug最終的なディレクトリ構成

fastapi_sample ├── Dockerfile ├── docker │ ├── nginx │ │ ├── conf.d │ │ │ └── app.conf │ │ └── ssl │ │ ├── server.crt │ │ ├── server.csr │ │ └── server.key │ ├── rundevserver.sh │ └── wait-for-it.sh ├── docker-compose.yml ├── main.py └── requirements.txtコンテナ起動

$ docker-compose up -dこんなエラーが出た場合は、Dockerイメージがディスクを逼迫している可能性があるので、

docker image pruneで不要なイメージを削除してください。(僕はこれで40GB分ディスクに空きができました?). .. ... Get:1 http://security.debian.org/debian-security buster/updates InRelease [65.4 kB] Get:2 http://deb.debian.org/debian buster InRelease [122 kB] Get:3 http://deb.debian.org/debian buster-updates InRelease [49.3 kB] Err:1 http://security.debian.org/debian-security buster/updates InRelease At least one invalid signature was encountered. Err:2 http://deb.debian.org/debian buster InRelease At least one invalid signature was encountered. Err:3 http://deb.debian.org/debian buster-updates InRelease At least one invalid signature was encountered. Reading package lists... W: GPG error: http://security.debian.org/debian-security buster/updates InRelease: At least one invalid signature was encountered. E: The repository 'http://security.debian.org/debian-security buster/updates InRelease' is not signed. W: GPG error: http://deb.debian.org/debian buster InRelease: At least one invalid signature was encountered. E: The repository 'http://deb.debian.org/debian buster InRelease' is not signed. W: GPG error: http://deb.debian.org/debian buster-updates InRelease: At least one invalid signature was encountered. E: The repository 'http://deb.debian.org/debian buster-updates InRelease' is not signed. ... .. .ブラウザからアクセス

コンテナの起動が完了したか確認します。

STATUS列が"Up..."となっていればOKです。$ docker ps CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES b77fa2465fb1 nginx:alpine "/docker-entrypoint.…" About a minute ago Up About a minute 0.0.0.0:80->80/tcp, 0.0.0.0:443->443/tcp nginx_fastapi_sample eb18438efd2c fastapi_sample_app "/fastapi_sample/doc…" About a minute ago Up About a minute 8000/tcp app_fastapi_sample 383b0e46af68 postgres:12.4-alpine "docker-entrypoint.s…" About a minute ago Up About a minute 0.0.0.0:5432->5432/tcp db_fastapi_samplehttps://localhostにアクセスして、

{"message":"Hello World"}が表示されれば完了です。ライブラリ「pydantic」を使用して環境変数(.env)を扱う

.envファイル作成$ touch .envfastapi_sample/.envDEBUG=True DATABASE_URL=postgresql://postgres:postgres@db:5432/db_fastapi_sample「pydatic」を使って環境変数を読み込む設定ファイルを作成

ライブラリ「pydantic」を使うと、.env から値を読み込む処理を簡単に実装できます。

また型に合わせてキャストしてくれたりするので超便利。

os.getenv('DEBUG') == 'True'みたいな気持ち悪い条件式を書かなくてよくなります。(distutils.util.strtobool使えって話ですが、、、)pydanticをインストール

fastapi_sample/requirements.txtpydantic[email]==1.6.1 # 追記したらpip3 installフォルダ「core」を作成、その直下に「config.py」を作成

$ mkdir core $ touch core/config.pyfastapi_sample/core/config.pyimport os from functools import lru_cache from pydantic import BaseSettings PROJECT_ROOT = os.path.dirname(os.path.dirname(os.path.abspath(__file__))) class Environment(BaseSettings): """ 環境変数を読み込むファイル """ debug: bool # .envから読み込んだ値をbool型にキャッシュ database_url: str class Config: env_file = os.path.join(PROJECT_ROOT, '.env') @lru_cache def get_env(): """ 「@lru_cache」でディスクから読み込んだ.envの結果をキャッシュする """ return Environment()alembic(マイグレーションツール)環境の用意 と モデルを用意

何はともあれインストール

requirements.txtに alembic と sqlalchemy 追記してから

pip3 install -r requirements.txtでインストール

(Dockerの手順を踏んでいる人はdocker-compose restart appまたはdocker-compose exec app pip3 install -r requiements.txt)fastapi_samepl/requirements.txtalembic==1.4.2 # 追記 . .. ... psycopg2==2.8.6 # 追記 . .. ... SQLAlchemy==1.3.18 # 追記 SQLAlchemy-Utils==0.36.8 # 追記プロジェクトルート直下にalembic環境を作成する

$ alembic init migrations # Dockerの手順を踏んだ人はdocker-compose exec app alembic init migrationsプロジェクトルートにalembicテンプレートが作成されます。(alembic.ini, migrationsフォルダ)

fastapi_sample(プロジェクトルート) ├── ... ├── .. ├── . ├── alembic.ini ├── migrations │ ├── README │ ├── env.py │ ├── script.py.mako │ └── versions └── ...ベースモデルを用意

modelsフォルダを作成し、まずはベースモデルを実装します。mkdir models touch models/base.pyfastapi_sample/migrations/models/base.pyfrom sqlalchemy import Column from sqlalchemy.dialects.postgresql import INTEGER, TIMESTAMP from sqlalchemy.ext.declarative import declarative_base, declared_attr from sqlalchemy.sql.functions import current_timestamp Base = declarative_base() class BaseModel(Base): """ ベースモデル """ __abstract__ = True id = Column( INTEGER, primary_key=True, autoincrement=True, ) created_at = Column( 'created_at', TIMESTAMP(timezone=True), server_default=current_timestamp(), nullable=False, comment='登録日時', ) updated_at = Column( 'updated_at', TIMESTAMP(timezone=True), onupdate=current_timestamp(), comment='最終更新日時', ) @declared_attr def __mapper_args__(cls): """ デフォルトのオーダリングは主キーの昇順 降順にしたい場合 from sqlalchemy import desc # return {'order_by': desc('id')} """ return {'order_by': 'id'}ユーザーモデルを用意

モデルはなんでもいいですが、認証編を書くときに使えそうなのでユーザーモデルを作成します。

fastapi_sample/migrations/models/user.pyfrom migrations.models.base import BaseModel from sqlalchemy import ( BOOLEAN, VARCHAR, Column, ) class User(BaseModel): __tablename__ = 'users' email = Column(VARCHAR(254), unique=True, nullable=False) password = Column(VARCHAR(128), nullable=False) last_name = Column(VARCHAR(100), nullable=False) first_name = Column(VARCHAR(100), nullable=False) is_admin = Column(BOOLEAN, nullable=False, default=False) is_active = Column(BOOLEAN, nullable=False, default=True)ユーザーモデルがマイグレーション対象にする

__init__.pyを作成touch models/__init__.pyfastapi_sample/migrations/models/__init__.pyfrom migrations.models import user # これだけ追記 # from migrations.models import school # モデルが増えた場合はこのファイルにインポート文を忘れずに追加する # インポート文を大量に書きたくない人は動的インポートをお試しあれ(こっちにする場合は、上のインポート文は消してください) # import importlib # import os # IGNORE_FILE_NAMES = ['__init__.py', '__pycache__'] # MODEL_FILES = os.listdir(os.path.dirname(__file__)) # [ # importlib.import_module( # f'migrations.models.{model_file.replace(".py", "")}', # ) # for model_file in MODEL_FILES # if model_file not in IGNORE_FILE_NAMES # ]env.pyを編集する

fastapi_sample/migrations/env.pyfrom migrations import models # __init__.pyをロード ... .. . target_metadata = models.base.Base.metadata # メタデータをセット ... .. .DBの接続先を変更

モデルを実装したところで、早速マイグレーションを行いたいところです。

が、alembicがプロジェクトテンプレートのままなのでalembic.iniのなかのデータベースURLもテンプレートのままです。fastapi_sample/alembic.ini. .. ... sqlalchemy.url = driver://user:pass@localhost/dbname ... .. .なので勿論alembicのマイグレーションファイル生成コマンドなどは失敗してしまいます。

$ docker-compose exec app alembic revision --autogenerate Traceback (most recent call last): File "/root/local/python-3.8.5/bin/alembic", line 8, in <module> sys.exit(main()) ... (長いので省略) . cls = registry.load(name) File "/root/local/python-3.8.5/lib/python3.8/site-packages/sqlalchemy/util/langhelpers.py", line 267, in load raise exc.NoSuchModuleError( sqlalchemy.exc.NoSuchModuleError: Can't load plugin: sqlalchemy.dialects:driveralembic.iniを直接書き換えるのもいいですが、開発環境やステージング、本番環境でそれぞれ異なるalembic.iniファイルができてしまい気持ち悪いです。

なので、マイグレーションファイル生成時やマイグレート実行時は、alembic.iniのデータベースURLを一時的に.envのDATABASE_URLで書き換えるようにしてみます。

python-dotenvをインストールfastapi_sample/requirements.txtpython-dotenv==0.14.0 # 追記したらインストールする

env.pyを修正fastapi_sample/migrations/env.pyimport os from core.config import PROJECT_ROOT from dotenv import load_dotenv . .. ... # other values from the config, defined by the needs of env.py, # can be acquired: # my_important_option = config.get_main_option("my_important_option") # ... etc. # alembic.iniの'sqlalchemy.url'を.envのDATABASE_URLで書き換える load_dotenv(dotenv_path=os.path.join(PROJECT_ROOT, '.env')) config.set_main_option('sqlalchemy.url', os.getenv('DATABASE_URL')) def run_migrations_offline(): ... .. .再度マイグレーションファイル生成コマンド実行

% docker-compose exec app alembic revision --autogenerate None /fastapi_sample INFO [alembic.runtime.migration] Context impl PostgresqlImpl. INFO [alembic.runtime.migration] Will assume transactional DDL. INFO [alembic.autogenerate.compare] Detected added table 'users' Generating /fastapi_sample/migrations/versions/2bc0a23e563c_.py ... doneマイグレーションファイルを生成できました。

migrations ├── ... ├── ... ├── models └── versions └── 2bc0a23e563c_.py # マイグレーションファイルができた。ただ、今のままだとマイグレーションファイルの生成順がパッと見でわからないのと、マイグレーションファイル内に記載してある生成日時(Create Date)がUTCのままなので日本時間に変えたいです。

alembic.iniを修正します。

fastapi_sample/alembic.ini. .. ... [alembic] # path to migration scripts script_location = migrations # ファイルの接頭に「YYYYMMDD_HHMMSS_」がつくようにする # template used to generate migration files file_template = %%(year)d%%(month).2d%%(day).2d_%%(hour).2d%%(minute).2d%%(second).2d_%%(rev)s_%%(slug)s # タイムゾーンを日本時間に # timezone to use when rendering the date # within the migration file as well as the filename. # string value is passed to dateutil.tz.gettz() # leave blank for localtime timezone = Asia/Tokyo ... .. .先ほど生成したマイグレーションファイルを消して、再度マイグレーションファイルを生成します。

migrations ├── ... ├── ... ├── models └── versions └── 20201024_200033_8a19c4c579bf_.py # ファイル内のCreate Dateも日本時間になっているマイグレート実行

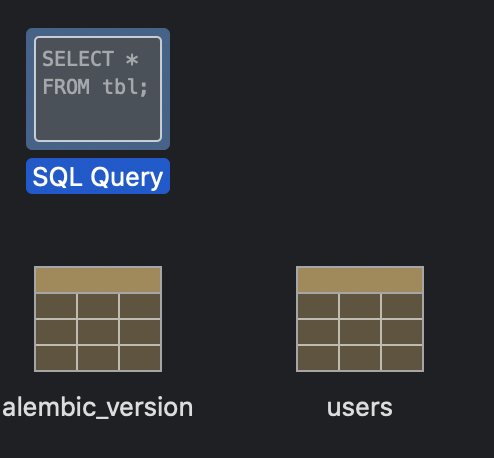

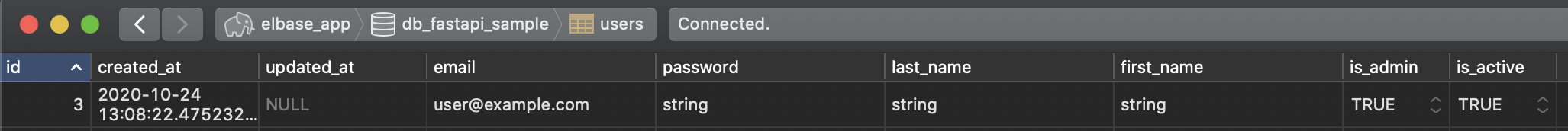

$ alembic upgrade head # Dockerの手順を踏んだ人はdocker-compose exec app alembic upgrade headちゃんとユーザーテーブルが作成されています。

(alembic_versionはalembicがバージョン管理に使用するテーブルで、自動生成されます)

データアクセスクラス作成

ベースのデータアクセスクラスを作成

単純な全件取得や1件取得、登録、更新、削除などを記載します。

base.pyに記載しているget_db_session()は後述するリクエストミドルウェアやテストコード実行時などで大変重要な役割を果たします、今は気にしなくて良いです。mkdir crud touch crud/base.pyfastapi_sample/crud/base.pyfrom core.config import get_env from migrations.models.base import Base from sqlalchemy import create_engine from sqlalchemy.orm import sessionmaker, scoped_session, query from typing import List, TypeVar ModelType = TypeVar("ModelType", bound=Base) connection = create_engine( get_env().database_url, echo=get_env().debug, encoding='utf-8', ) Session = scoped_session(sessionmaker(connection)) def get_db_session() -> scoped_session: yield Session class BaseCRUD: """ データアクセスクラスのベース """ model: ModelType = None def __init__(self, db_session: scoped_session) -> None: self.db_session = db_session self.model.query = self.db_session.query_property() def get_query(self) -> query.Query: """ ベースのクエリ取得 """ return self.model.query def gets(self) -> List[ModelType]: """ 全件取得 """ return self.get_query().all() def get_by_id(self, id: int) -> ModelType: """ 主キーで取得 """ return self.get_query().filter_by(id=id).first() def create(self, data: dict = {}) -> ModelType: """ 新規登録 """ obj = self.model() for key, value in data.items(): if hasattr(obj, key): setattr(obj, key, value) self.db_session.add(obj) self.db_session.flush() self.db_session.refresh(obj) return obj def update(self, obj: ModelType, data: dict = {}) -> ModelType: """ 更新 """ for key, value in data.items(): if hasattr(obj, key): setattr(obj, key, value) self.db_session.flush() self.db_session.refresh(obj) return obj def delete_by_id(self, id: int) -> None: """ 主キーで削除 """ obj = self.get_by_id(id) if obj: obj.delete() self.db_session.flush() return Noneユーザーデータアクセスクラスを作成

touch crud/crud_user.pyfastapi_sample/crud/crud_user.pyfrom crud.base import BaseCRUD from migrations.models.user import User class CRUDUser(BaseCRUD): """ ユーザーデータアクセスクラスのベース """ model = UserAPI実装

お待たせしました、ようやくAPI実装編です。

API実装前準備

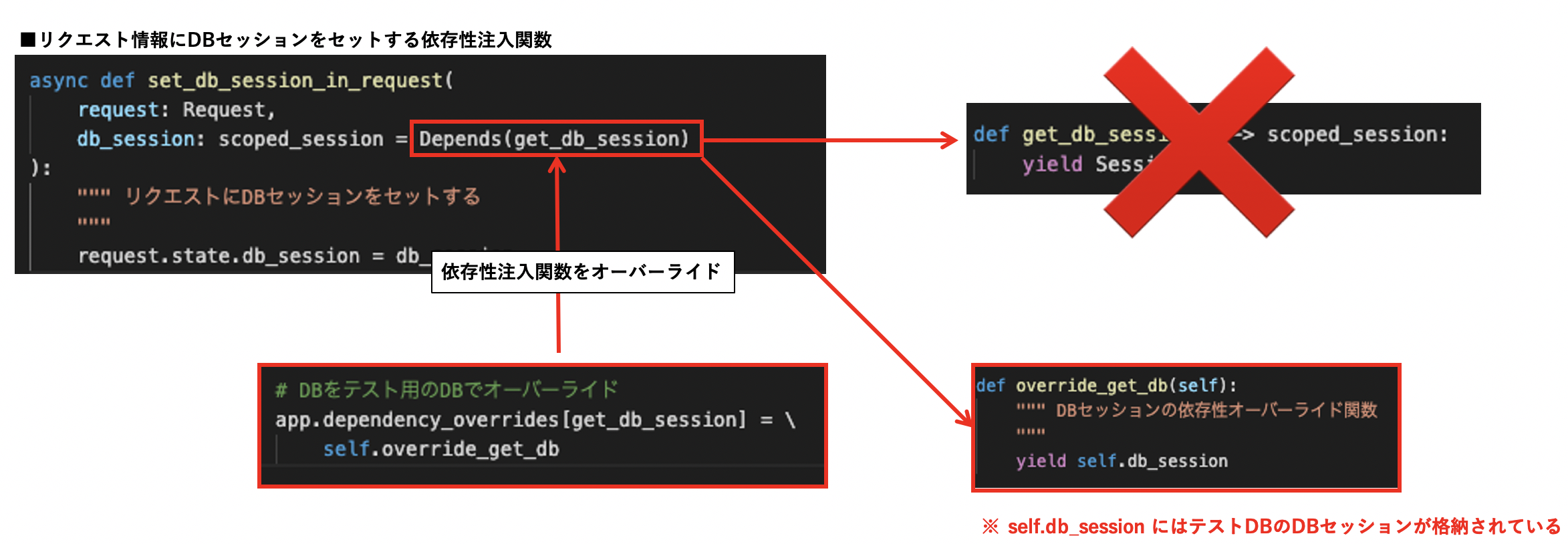

リクエスト情報にDBセッションを格納する依存性注入用(Depends)の関数を実装します。

このFastAPIの依存性注入システムがとても強力で、パラメーターをまとめたりもすることができます。

完全に理解しているわけではないので、申し訳ないのですが詳細は公式ドキュメントを参照してください。mkdir dependencies touch dependencies/__init__.pydependencies/__init__.pyfrom fastapi import Depends, Request from crud.base import get_db_session from sqlalchemy.orm import scoped_session async def set_db_session_in_request( request: Request, db_session: scoped_session = Depends(get_db_session) ): """ リクエストにDBセッションをセットする """ request.state.db_session = db_sessionAPIを実装していくフォルダ作成

mkdir -p api/v1ユーザーの一覧取得API実装

touch api/v1/user.pyfastapi_sample/api/v1/user.pyfrom crud.base import Session from crud.crud_user import CRUDUser from fastapi import Request from fastapi.encoders import jsonable_encoder class UserAPI: """ ユーザーに関するAPI """ @classmethod def gets(cls, request: Request): """ 一覧取得 """ # 依存性注入システムを用いて、リクエスト情報にDBセッションをセットしたので、 # ここで「request.state.db_session」を使用することができる return jsonable_encoder(CRUDUser(request.state.db_session).gets())APIルーター実装

ルーターの

dependencies=[Depends(set_db_session_in_request)]が今後重要な機能を果たしてくれますmkdir -p api/endpoints/v1 touch api/endpoints/v1/user.pyfastapi_sample/api/endpoints/v1/user.pyfrom api.v1.user import UserAPI from dependencies import set_db_session_in_request from fastapi import APIRouter, Depends, Request router = APIRouter() @router.get( '/', dependencies=[Depends(set_db_session_in_request)]) async def gets(request: Request): return UserAPI.gets(request)ルーターをエントリーポイントに登録する

APIルーターを作成

touch api/endpoints/v1/__init__.pyfastapi_sample/api/endpoints/v1/__init__.pyfrom fastapi import APIRouter from api.endpoints.v1 import user api_v1_router = APIRouter() api_v1_router.include_router( user.router, prefix='users', tags=['users'])main.pyを編集

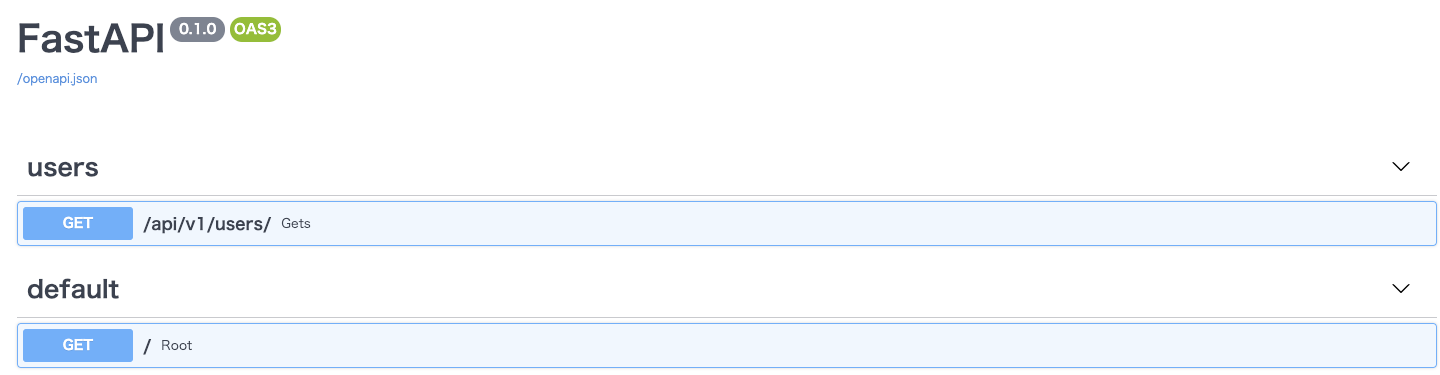

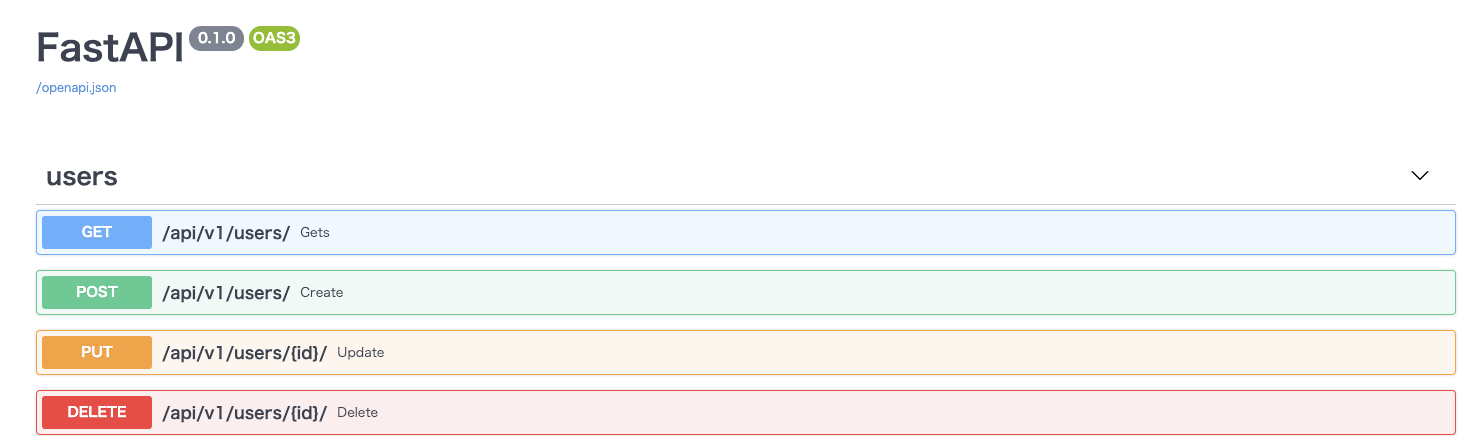

fastapi_sample/main.pyfrom api.endpoints.v1 import api_v1_router # 追記 from fastapi import FastAPI app = FastAPI() app.include_router(api_v1_router, prefix='/api/v1') # 追記 @app.get("/") async def root(): return {"message": "Hello World"}ブラウザからhttps://localhost/docsアクセスすると実装したAPIが表示されているはずです。

登録/更新用にスキーマ(フォーム?)を定義する

mkdir api/schemas touch api/schemas/user.pyfastapi_sample/api/schemas/user.pyfrom pydantic import BaseModel, EmailStr from typing import Optional class BaseUser(BaseModel): email: EmailStr last_name: str first_name: str is_admin: bool class CreateUser(BaseUser): password: str class UpdateUser(BaseUser): password: Optional[str] last_name: Optional[str] first_name: Optional[str] is_admin: bool class UserInDB(BaseUser): class Config: orm_mode = Trueユーザーの登録/更新/削除のAPIを追加

fastapi_sample/api/v1/user.pyfrom api.schemas.user import CreateUser, UpdateUser, UserInDB from crud.crud_user import CRUDUser from fastapi import Request # from fastapi.encoders import jsonable_encoder # 削除 from typing import List class UserAPI: """ ユーザーに関するAPI """ @classmethod def gets(cls, request: Request) -> List[UserInDB]: """ 一覧取得 """ return CRUDUser(request.state.db_session).gets() # jsonable_encoderは使わない @classmethod def create( cls, request: Request, schema: CreateUser ) -> UserInDB: """ 新規登録 """ return CRUDUser(request.state.db_session).create(schema.dict()) @classmethod def update( cls, request: Request, id: int, schema: UpdateUser ) -> UserInDB: """ 更新 """ crud = CRUDUser(request.state.db_session) obj = crud.get_by_id(id) return CRUDUser(request.state.db_session).update(obj, schema.dict()) @classmethod def delete(cls, request: Request, id: int) -> None: """ 削除 """ return CRUDUser(request.state.db_session).delete_by_id(id)ユーザーのAPIルーターを編集

fastapi_sample/api/endpoints/v1/user.pyfrom api.schemas.user import CreateUser, UpdateUser, UserInDB from api.v1.user import UserAPI from dependencies import set_db_session_in_request from fastapi import APIRouter, Depends, Request from typing import List router = APIRouter() @router.get( '/', response_model=List[UserInDB], # response_modelを追加 dependencies=[Depends(set_db_session_in_request)]) def gets(request: Request) -> List[UserInDB]: """ 一覧取得 """ return UserAPI.gets(request) @router.post( '/', response_model=UserInDB, dependencies=[Depends(set_db_session_in_request)]) def create(request: Request, schema: CreateUser) -> UserInDB: """ 新規登録 """ return UserAPI.create(request, schema) @router.put( '/{id}/', response_model=UserInDB, dependencies=[Depends(set_db_session_in_request)]) def update(request: Request, id: int, schema: UpdateUser) -> UserInDB: """ 更新 """ return UserAPI.update(request, id, schema) @router.delete( '/{id}/', dependencies=[Depends(set_db_session_in_request)]) def delete(request: Request, id: int) -> None: """ 削除 """ return UserAPI.delete(request, id)ブラウザからアクセスして確認

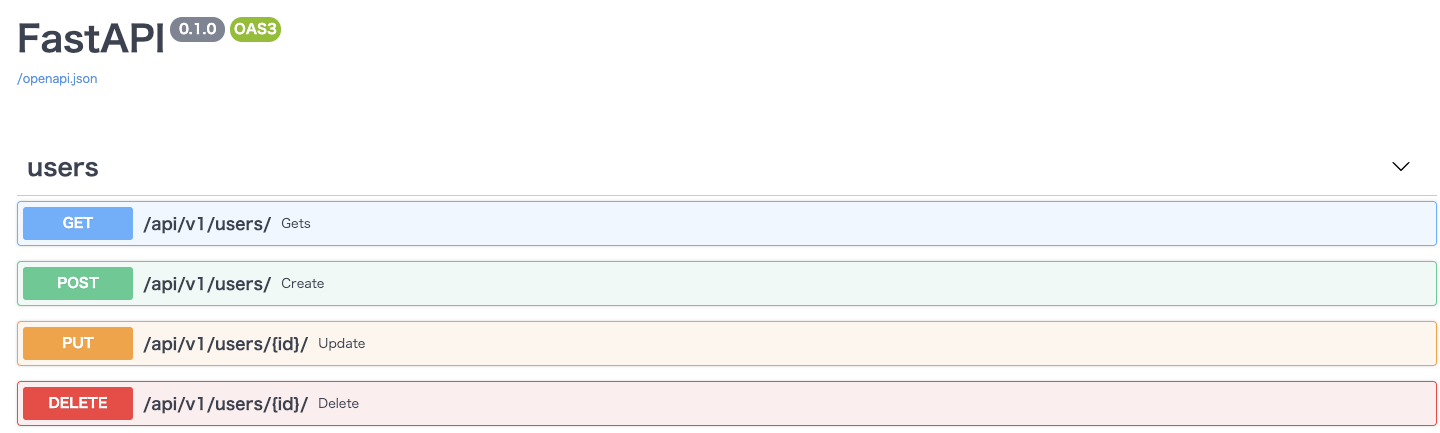

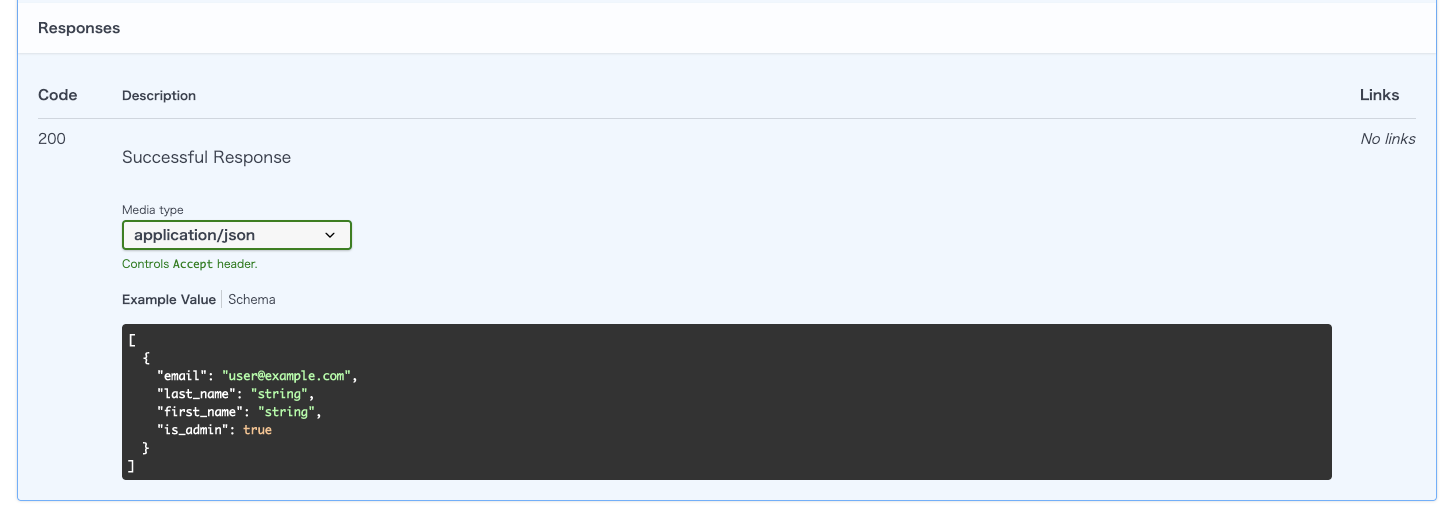

routerに

response_modelを指定すると、DBから取得したオブジェクトのJSONシリアライズを開発者が明示的に実装する必要がなくなります。(jsonable_encoder()を使わなくて良くなったのはこれのおかげ)

また、swagger-UI上にも反映してくれます。

※一覧取得のレスポンス

リクエストミドルウェアを実装する

さて、APIは実行できましたが、DBセッションのコミット実行していないので登録/更新/削除を実行してもDBが変更されません。

変更をDBに反映させるため、以下のようなリクエストミドルウェアを実装して適用します。

・リクエストが完了したらDBセッションコミットしてからDBセッション破棄

・エラー発生時はロールバックしてからDBセッション破棄mkdir middleware touch middleware/__init__.pyfastapi_sample/middleware/__init__.pyfrom fastapi import Request, Response from starlette.middleware.base import BaseHTTPMiddleware class HttpRequestMiddleware(BaseHTTPMiddleware): async def dispatch(self, request: Request, call_next) -> Response: try: response = await call_next(request) # 予期せぬ例外 except Exception as e: print(e) request.state.db_session.rollback() raise e # 正常終了時 else: request.state.db_session.commit() return response # DBセッションの破棄は必ず行う finally: request.state.db_session.remove()エントリーポイントにミドルウェアを適用する

fastapi_sample/main.pyfrom api.endpoints.v1 import api_v1_router from fastapi import FastAPI from middleware import HttpRequestMiddleware # 追加 app = FastAPI() app.include_router(api_v1_router, prefix='/api/v1') # ミドルウェアの設定 app.add_middleware(HttpRequestMiddleware) # 追加 @app.get("/") async def root(): return {"message": "Hello World"}CRUD実行で確認

テストコード実装編

CRUDを実装できたので、次はテストコードを実装していきます。

とはいえ、単純にテストコードからAPIを実行してしまうと、DBに登録・更新・削除が実行されるため、テスト実行ごとに結果が変わってしまう可能性があります。

それを防ぐため、テスト関数ごとにクリーンなDBを作成し、そのDBを使用してテストするようにしたいと思います。pytestをインストール

fastapi_sample/requirements.txtpytest==6.1.0 # 追記したらrequirements.txtをインストールし直すのを忘れずにテスト用のDB接続情報を環境変数に追加

fastapi_sample/.envDEBUG=True DATABASE_URL=postgresql://postgres:postgres@db:5432/db_fastapi_sample TEST_DATABASE_URL=postgresql://postgres:postgres@db:5432/test_db_fastapi_sample # 追加fastapi_sample/core/config.pyclass Environment(BaseSettings): """ 環境変数を読み込むファイル """ debug: bool database_url: str test_database_url: str # 追加テストコード実装用のフォルダ作成

mkdir testsAPIのベーステストクラスを作成

touch tests/base.pyfastapi_sample/tests/base.pyimport psycopg2 from core.config import get_env from crud.base import Base, get_db_session from fastapi.testclient import TestClient from main import app from psycopg2.extensions import ISOLATION_LEVEL_AUTOCOMMIT from sqlalchemy import create_engine from sqlalchemy.orm import scoped_session, sessionmaker from sqlalchemy_utils import database_exists, drop_database test_db_connection = create_engine( get_env().test_database_url, encoding='utf8', pool_pre_ping=True, ) class BaseTestCase: def setup_method(self, method): """ 前処理 """ # テストDB作成 self.__create_test_database() self.db_session = self.get_test_db_session() # APIクライアントの設定 self.client = TestClient(app, base_url='https://localhost',) # DBをテスト用のDBでオーバーライド app.dependency_overrides[get_db_session] = \ self.override_get_db def teardown_method(self, method): """ 後処理 """ # テストDB削除 self.__drop_test_database() # オーバーライドしたDBを元に戻す app.dependency_overrides[self.override_get_db] = \ get_db_session def override_get_db(self): """ DBセッションの依存性オーバーライド関数 """ yield self.db_session def get_test_db_session(self): """ テストDBセッションを返す """ return scoped_session(sessionmaker(bind=test_db_connection)) def __create_test_database(self): """ テストDB作成 """ # テストDBが削除されずに残ってしまっている場合は削除 if database_exists(get_env().test_database_url): drop_database(get_env().test_database_url) # テストDB作成 _con = \ psycopg2.connect('host=db user=postgres password=postgres') _con.set_isolation_level(ISOLATION_LEVEL_AUTOCOMMIT) _cursor = _con.cursor() _cursor.execute('CREATE DATABASE test_db_fastapi_sample') # テストDBにExtension追加 _test_db_con = psycopg2.connect( 'host=db dbname=test_db_fastapi_sample user=postgres password=postgres' ) _test_db_con.set_isolation_level(ISOLATION_LEVEL_AUTOCOMMIT) # テストDBにテーブル追加 Base.metadata.create_all(bind=test_db_connection) def __drop_test_database(self): """ テストDB削除 """ drop_database(get_env().test_database_url)ポイントはこのDBオーバーライド部分です。

アプリケーションが参照するDBをテストDBに切り替えています。# DBをテスト用のDBでオーバーライド app.dependency_overrides[get_db_session] = self.override_get_dbこうすることで、APIやミドルウェアで使用している「request.state.db_session」もテストDBに切り替えることができます。

一覧取得のテストコードを実装してみる

requirements.txtrequests==2.24.0 # 追記したら必ずrequirements.txtをインストールmkdir -p tests/api/v1 touch tests/api/v1/test_user.py # "test_"を接頭に付けないとpytest実行時にスルーされてしまうので必ずつけるfastapi_sample/tests/api/v1/test_user.pyimport json from crud.crud_user import CRUDUser from fastapi import status from tests.base import BaseTestCase class TestUserAPI(BaseTestCase): """ ユーザーAPIのテストクラス """ TEST_URL = '/api/v1/users/' def test_gets(self): """ 一覧取得のテスト """ # テストユーザー登録 test_data = [ { 'email': 'test1@example.com', 'password': 'password', 'last_name': 'last_name', 'first_name': 'first_name', 'is_admin': False }, { 'email': 'test2@example.com', 'password': 'password', 'last_name': 'last_name', 'first_name': 'first_name', 'is_admin': True }, { 'email': 'test3@example.com', 'password': 'password', 'last_name': 'last_name', 'first_name': 'first_name', 'is_admin': False }, ] for data in test_data: CRUDUser(self.db_session).create(data) self.db_session.commit() response = self.client.get(self.TEST_URL) # ステータスコードの検証 assert response.status_code == status.HTTP_200_OK # 取得した件数の検証 response_data = json.loads(response._content) assert len(response_data) == len(test_data) # レスポンスの内容を検証 expected_data = [{ 'email': item['email'], 'last_name': item['last_name'], 'first_name': item['first_name'], 'is_admin': item['is_admin'], } for i, item in enumerate(test_data, 1)] assert response_data == expected_dataテスト実行

pytest # Dockerの手順を踏んだ方は、docker-compose exec app pytest # print()文の出力を確認したい場合は、pytest -v --capture=no% docker-compose exec app pytest -v --capture=no ================================================================================================== test session starts =================================================================================================== platform linux -- Python 3.8.5, pytest-6.1.0, py-1.9.0, pluggy-0.13.1 -- /root/local/python-3.8.5/bin/python3.8 cachedir: .pytest_cache rootdir: /fastapi_sample collected 1 item tests/api/v1/test_user.py::TestUserAPI::test_gets PASSED # 成功 ==================================================================================================== warnings summary ==================================================================================================== <string>:2 <string>:2: SADeprecationWarning: The mapper.order_by parameter is deprecated, and will be removed in a future release. Use Query.order_by() to determine the ordering of a result set. -- Docs: https://docs.pytest.org/en/stable/warnings.htmlテストも無事成功しました。

データベースを確認してみましょう。

API実装時に試しに登録したデータしかありません。

テスト用のDBに切り替えてのテスト実行は成功したようです!ローカルDBを汚さず、かつ テストケースごとのテストデータも干渉することなくテストコードを実行することができるようになりました。

やったね。リクエストミドルウェア実装後、swagger-UI表示時「Internal Server Error」になる

swagger-UI表示時、「request.state」に「db_session」が存在しないため、Key Errorで「Internal Server Error」となります。

手取り早く直したい場合

リクエストミドルウェアの「request.state.db_session」を以下のように書き換えます。

fastapi_sample/middleware/__init__.pyfrom crud.base import Session # 追加 from fastapi import Request, Response from starlette.middleware.base import BaseHTTPMiddleware class HttpRequestMiddleware(BaseHTTPMiddleware): async def dispatch(self, request: Request, call_next) -> Response: try: response = await call_next(request) # 予期せぬ例外 except Exception as e: print(e) getattr(request.state, 'db_session', Session).rollback() # これに書き換え raise e # 正常終了時 else: getattr(request.state, 'db_session', Session).commit() # これに書き換え return response # DBセッションの破棄は必ず行う finally: getattr(request.state, 'db_session', Session).remove() # これに書き換えリクエストミドルウェアは触りたくない場合

swagger-uiで表示するエンドポイントを全てオーバーライドするしかありません。

FastAPIクラスをオーバーライド

touch core/fastapi.pyfastapi_sample/core/fastapi.pyimport fastapi from fastapi import Request from fastapi.exceptions import RequestValidationError from fastapi.exception_handlers import ( http_exception_handler, request_validation_exception_handler, ) from fastapi.openapi.docs import ( get_redoc_html, get_swagger_ui_html, get_swagger_ui_oauth2_redirect_html, ) from fastapi.responses import JSONResponse, HTMLResponse from starlette.exceptions import HTTPException class FastAPI(fastapi.FastAPI): def setup(self) -> None: if self.openapi_url: urls = (server_data.get("url") for server_data in self.servers) server_urls = {url for url in urls if url} async def openapi(req: Request) -> JSONResponse: root_path = req.scope.get("root_path", "").rstrip("/") if root_path not in server_urls: if root_path and self.root_path_in_servers: self.servers.insert(0, {"url": root_path}) server_urls.add(root_path) return JSONResponse(self.openapi(self, req)) # 書き換えているのはこの部分だけ self.add_route(self.openapi_url, openapi, include_in_schema=False) if self.openapi_url and self.docs_url: async def swagger_ui_html(req: Request) -> HTMLResponse: root_path = req.scope.get("root_path", "").rstrip("/") openapi_url = root_path + self.openapi_url oauth2_redirect_url = self.swagger_ui_oauth2_redirect_url if oauth2_redirect_url: oauth2_redirect_url = root_path + oauth2_redirect_url return get_swagger_ui_html( openapi_url=openapi_url, title=self.title + " - Swagger UI", oauth2_redirect_url=oauth2_redirect_url, init_oauth=self.swagger_ui_init_oauth, ) self.add_route( self.docs_url, swagger_ui_html, include_in_schema=False ) if self.swagger_ui_oauth2_redirect_url: async def swagger_ui_redirect(req: Request) -> HTMLResponse: return get_swagger_ui_oauth2_redirect_html() self.add_route( self.swagger_ui_oauth2_redirect_url, swagger_ui_redirect, include_in_schema=False, ) if self.openapi_url and self.redoc_url: async def redoc_html(req: Request) -> HTMLResponse: root_path = req.scope.get("root_path", "").rstrip("/") openapi_url = root_path + self.openapi_url return get_redoc_html( openapi_url=openapi_url, title=self.title + " - ReDoc" ) self.add_route(self.redoc_url, redoc_html, include_in_schema=False) self.add_exception_handler(HTTPException, http_exception_handler) self.add_exception_handler( RequestValidationError, request_validation_exception_handler )swagger-ui用のルーターを用意

touch api/endpoints/swagger_ui.pyfastapi_sample/api/endpoints/swagger_ui.pyfrom core.fastapi import FastAPI from crud.base import Session from dependencies import set_db_session_in_request from fastapi import APIRouter, Depends, Request from fastapi.openapi.docs import get_redoc_html, get_swagger_ui_html from fastapi.openapi.utils import get_openapi swagger_ui_router = APIRouter() @swagger_ui_router.get( '/docs', include_in_schema=False, dependencies=[Depends(set_db_session_in_request)]) async def swagger_ui_html(request: Request): return get_swagger_ui_html( openapi_url=FastAPI().openapi_url, title=FastAPI().title, oauth2_redirect_url=FastAPI().swagger_ui_oauth2_redirect_url, ) @swagger_ui_router.get( '/redoc', include_in_schema=False, dependencies=[Depends(set_db_session_in_request)]) async def redoc_html(request: Request): return get_redoc_html( openapi_url=FastAPI().openapi_url, title=FastAPI().title + " - ReDoc", ) def openapi(app: FastAPI, request: Request): request.state.db_session = Session if app.openapi_schema: return app.openapi_schema openapi_schema = get_openapi( title="FastAPI", version="0.1.0", routes=app.routes, ) app.openapi_schema = openapi_schema return app.openapi_schemaエントリーポイント修正

fastapi_sample/main.pyfrom api.endpoints.swagger_ui import openapi, swagger_ui_router from api.endpoints.v1 import api_v1_router from core.config import get_env # from fastapi import FastAPI from core.fastapi import FastAPI # オーバーライドしたFastAPIクラスを使用する from middleware import HttpRequestMiddleware app = FastAPI( docs_url=None, # Noneを設定しないとswagger-uiのルーターで定義したものに変わらない redoc_url=None, # Noneを設定しないとswagger-uiのルーターで定義したものに変わらない ) app.include_router(api_v1_router, prefix='/api/v1') # ミドルウェアの設定 app.add_middleware(HttpRequestMiddleware) # @app.get("/") # async def root(): # return {"message": "Hello World"} # swagger-uiは開発時のみ表示されるようにする if get_env().debug: app.include_router(swagger_ui_router) app.openapi = openapi無事swagger-uiのエラーが解消され、表示されるようになりました。

終わり

FastAPIでCRUDを実装してみました。

フルスタックフレームワークのDjango(RestはDRF)ばかり使っていたせいで、初め「なんだこの使いづらいフレームワークは・・・」とか思っていましたが、今ではもうDjangoよりFastAPI派になってしまいました。

ガシガシ環境周りのコードを自分で実装できて楽しいですし、何より成長に繋がりました。

公式ドキュメントを読みきれていないので、他にもいい方法はあるかと思いますので、

コメントでこっそり教えてもらえると嬉しいです( ´ノω`)

私が所属しているFabeee株式会社はお仕事 と 一緒に働くお仲間を随時募集しております!!!!(宣伝)

- 投稿日:2020-10-24T23:32:09+09:00

FastAPI + SQLAlchemy(postgresql)でCRUD APIを実装してみた(Dockerやミドルウェア, テストコードなども含む)

アーキテクチャ

python: v3.8.5 postgresql: v12.4 fastapi: v0.60.2 SQLAlchemy: v1.3.18マイグレーションツール

alembic: v1.4.2FastAPIとは

詳細は既にQiitaにチョコチョコ記事あるので割愛します。

ドキュメントが豊富(読みきれてない)で、Swaggerと互換性あるのがとても素晴らしいです。

(パフォーマンスも良いらしいがベンチマーク測ったことないので断言できない、でも多分速い。)

しっかり触ったことのあるフレームワークはDjangoだけなのでミドルウェアやテストコード周り苦労した・・・。

(Djangoはフルスタックフレームワークで、勝手にいろいろやってくれるからミドルウェアとかテストの実装環境とかあまり気にしたことない)Python3.8.5の仮装環境作成

pyenv, virtualenvが入ってない場合は下記を参考に入れてください。

・Mac

・Windows$ pyenv virtualenv 3.8.5 env_fastapi_sample仮装環境を適用

プロジェクトルートを作成

$ mkdir fastapi_sampleプロジェクトルートにcd

$ cd fastapi_sample仮装環境を適用

$ pyenv local env_fastapi_samplerequirements.txt作成/インストール

$ touch requirements.txtrequirements.txtにfastapiを追記

fastapi_sample/requirements.txtfastapi==0.60.2 uvicorn==0.11.8仮装環境にインストール

$ pip3 install -r requirements.txtエントリーポイント(main.py)を作成して、Swagger-UIを表示してみる

エントリーポイント(main.py)作成

$ touch main.pymain.pyを編集

fastapi_sample/main.pyfrom fastapi import FastAPI app = FastAPI() @app.get("/") async def root(): return {"message": "Hello World"}Swagger-UI表示

$ uvicorn main:app --reloadブラウザから「http://127.0.0.1:8000」にアクセスして

{"message":"Hello World"}が表示されていれば完了です。Docker化

Nginxのリバースプロキシによってアプリケーションをhttpsで公開するようにします。

ベースのdocker-compose.yml

fastapi_sample/docker-compose.ymlversion: '3' services: # Nginxコンテナ nginx: container_name: nginx_fastapi_sample image: nginx:alpine depends_on: - app - db environment: TZ: "Asia/Tokyo" ports: - "80:80" - "443:443" volumes: - ./docker/nginx/conf.d:/etc/nginx/conf.d - ./docker/nginx/ssl:/etc/nginx/ssl # アプリケーションコンテナ app: build: context: . dockerfile: Dockerfile container_name: app_fastapi_sample volumes: - '.:/fastapi_sample/' environment: - LC_ALL=ja_JP.UTF-8 expose: - 8000 depends_on: - db entrypoint: /fastapi_sample/docker/wait-for-it.sh db 5432 postgres postgres db_fastapi_sample command: bash /fastapi_sample/docker/rundevserver.sh restart: always tty: true # DBコンテナ db: image: postgres:12.4-alpine container_name: db_fastapi_sample environment: - POSTGRES_USER=postgres - POSTGRES_PASSWORD=postgres - POSTGRES_DB=db_fastapi_sample - POSTGRES_INITDB_ARGS=--encoding=UTF-8 --locale=C volumes: - db_data:/var/lib/postgresql/data ports: - '5432:5432' volumes: db_data: driver: localNginxコンテナの設定

confファイルを用意する

$ mkdir -p nginx/conf.d $ touch nginx/conf.d/app.conffastapi_sample/docker/nginx/conf.d/app.confupstream backend { server app:8000; # appはdocker-compose.ymlの「app」 } # 80番ポートへのアクセスは443番ポートへのアクセスに強制する server { listen 80; return 301 https://$host$request_uri; } server { listen 443 ssl; ssl_certificate /etc/nginx/ssl/server.crt; ssl_certificate_key /etc/nginx/ssl/server.key; ssl_protocols TLSv1.2 TLSv1.3; location / { proxy_set_header Host $http_host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-Host $http_host; proxy_set_header X-Forwarded-Server $http_host; proxy_set_header X-Forwarded-Server $host; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header X-Forwarded-Proto $scheme; proxy_redirect http:// https://; proxy_pass http://backend; } # ログを出力したい場合はコメントアウト外してください # access_log /var/log/nginx/access.log; # error_log /var/log/nginx/error.log; } server_tokens off;NginxのSSL化に必要なファイルを用意

$ mkdir -p nginx/conf.d nginx/sslOpenSSLを使って秘密鍵(server.key)を生成する

# ディレクトリ移動 $ cd nginx/conf.d # 秘密鍵生成 $ openssl genrsa 2024 > server.key # 確認 $ ls -ll total 8 -rw-r--r-- 1 user staff 1647 10 24 13:23 server.key証明書署名要求(server.csr)を生成

$ openssl req -new -key server.key > server.csr$ openssl req -new -key server.key > server.csr ... .. . Country Name (2 letter code) [AU]:JP # 国を示す2文字のISO略語 State or Province Name (full name) [Some-State]:Tokyo # 会社が置かれている都道府県 Locality Name (eg, city) []:Chiyodaku # 会社が置かれている市区町村 Organization Name (eg, company) [Internet Widgits Pty Ltd]:fabeee # 会社名 Organizational Unit Name (eg, section) []:- # 部署名(ハイフンにしました。) Common Name (e.g. server FQDN or YOUR name) []:localhost(ウェブサーバのFQDN。一応localhostにした) Email Address []: # 未入力でエンター Please enter the following 'extra' attributes to be sent with your certificate request A challenge password []: # 未入力でエンター An optional company name []: # 未入力でエンター ... .. . $ ls -ll total 16 -rw-r--r-- 1 user staff 980 10 24 13:27 server.csr # 証明書署名要求ができた -rw-r--r-- 1 user staff 1647 10 24 13:23 server.keyサーバ証明書(server.crt)を生成

openssl x509 -req -days 3650 -signkey server.key < server.csr > server.crt % ls -ll total 24 -rw-r--r-- 1 tabata staff 1115 10 24 13:40 server.crt # サーバ証明書ができた -rw-r--r-- 1 tabata staff 948 10 24 13:29 server.csr -rw-r--r-- 1 tabata staff 1647 10 24 13:23 server.keyサーバ証明書を信頼する

「この証明書を使用するとき」のプルダウンから「常に信頼する」を選択する

最終的にこうなっていればNginxの設定は完了です

fastapi_sample ├── docker │ └── nginx │ ├── conf.d │ │ └── app.conf │ └── ssl │ ├── server.crt │ ├── server.csr │ └── server.key ├── docker-compose.yml ├── main.py └── requirements.txtapp(FastAPI)コンテナの設定

Dockerfile

イメージはubuntu20.04です。

・pyenvでコンテナ内のpythonバージョンをv3.8.5にしている

・apt installで必要なモジュールをインストール(不要なものは削ってもらって構いません)

・pip3 install -r requirements.txtでpythonモジュールをコンテナ内にインストールFROM ubuntu:20.04 ENV DEBIAN_FRONTEND=noninteractive ENV HOME /root ENV PYTHONPATH /fastapi_sample/ ENV PYTHON_VERSION 3.8.5 ENV PYTHON_ROOT $HOME/local/python-$PYTHON_VERSION ENV PATH $PYTHON_ROOT/bin:$PATH ENV PYENV_ROOT $HOME/.pyenv RUN mkdir /fastapi_sample \ && rm -rf /var/lib/apt/lists/* RUN apt update && apt install -y git curl locales python3-pip python3-dev python3-passlib python3-jwt \ libssl-dev libffi-dev zlib1g-dev libpq-dev postgresql RUN echo "ja_JP UTF-8" > /etc/locale.gen \ && locale-gen RUN git clone https://github.com/pyenv/pyenv.git $PYENV_ROOT \ && $PYENV_ROOT/plugins/python-build/install.sh \ && /usr/local/bin/python-build -v $PYTHON_VERSION $PYTHON_ROOT WORKDIR /fastapi_sample ADD . /fastapi_sample/ RUN LC_ALL=ja_JP.UTF-8 \ && pip3 install -r requirements.txtwait-for-it.sh

データベースが立ち上がるのを待ってからappコンテナを起動するようにするためのシェルスクリプトです。

docker-componseに記載しているdepends_onでコンテナの起動順は制御できますが、

データベースが立ち上がっていない場合、appコンテナでエラーが発生することがあります。

(appコンテナ起動時にDB操作をするようなコマンドを実行しようとした場合、データベースが立ち上がっていないためにエラー、とか)fastapi_sample/docker/wait-for-it.sh#!/bin/sh set -e # 引数はdocker-compose.ymlで指定している。 # app: # ... # .. # . # entrypoint: /fastapi_sample/docker/wait-for-it.sh db 5432 postgres postgres db_fastapi_sample # ココ # ... host="$1" shift port="$1" shift user="$1" shift password="$1" shift database="$1" shift cmd="$@" echo "Waiting for postgresql" until pg_isready -h"$host" -U"$user" -p"$port" -d"$database" do echo -n "." sleep 1 done >&2 echo "PostgreSQL is up - executing command" exec $cmd # 僕は優しいのでMySQL用も書いてあげるのだ #!/bin/sh # set -e # host="$1" # shift # user="$1" # shift # password="$1" # shift # cmd="$@" # echo "Waiting for mysql" # until mysqladmin ping -h "$host" --silent # do # echo -n "." # sleep 1 # done # >&2 echo "MySQL is up - executing command" # exec $cmdrundevserver.sh

uvicornを起動してアプリケーションを起動するためのシェルスクリプトファイルです。

・docker-compose up時に毎回requirements.txtのモジュールを読み込む

・uvicornでアプリケーションを起動する

・--reloadでホットリロード(pythonファイルを変更すると即反映してくれる)

・--portを8000から変える場合はnginxのapp.conf内の8000も変える必要があるpip3 install -r requirements.txt uvicorn main:app\ --reload\ --port 8000\ --host 0.0.0.0\ --log-level debug最終的なディレクトリ構成

fastapi_sample ├── Dockerfile ├── docker │ ├── nginx │ │ ├── conf.d │ │ │ └── app.conf │ │ └── ssl │ │ ├── server.crt │ │ ├── server.csr │ │ └── server.key │ ├── rundevserver.sh │ └── wait-for-it.sh ├── docker-compose.yml ├── main.py └── requirements.txtコンテナ起動

$ docker-compose up -dこんなエラーが出た場合は、Dockerイメージがディスクを逼迫している可能性があるので、

docker image pruneで不要なイメージを削除してください。(僕はこれで40GB分ディスクに空きができました?). .. ... Get:1 http://security.debian.org/debian-security buster/updates InRelease [65.4 kB] Get:2 http://deb.debian.org/debian buster InRelease [122 kB] Get:3 http://deb.debian.org/debian buster-updates InRelease [49.3 kB] Err:1 http://security.debian.org/debian-security buster/updates InRelease At least one invalid signature was encountered. Err:2 http://deb.debian.org/debian buster InRelease At least one invalid signature was encountered. Err:3 http://deb.debian.org/debian buster-updates InRelease At least one invalid signature was encountered. Reading package lists... W: GPG error: http://security.debian.org/debian-security buster/updates InRelease: At least one invalid signature was encountered. E: The repository 'http://security.debian.org/debian-security buster/updates InRelease' is not signed. W: GPG error: http://deb.debian.org/debian buster InRelease: At least one invalid signature was encountered. E: The repository 'http://deb.debian.org/debian buster InRelease' is not signed. W: GPG error: http://deb.debian.org/debian buster-updates InRelease: At least one invalid signature was encountered. E: The repository 'http://deb.debian.org/debian buster-updates InRelease' is not signed. ... .. .ブラウザからアクセス

コンテナの起動が完了したか確認します。

STATUS列が"Up..."となっていればOKです。$ docker ps CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES b77fa2465fb1 nginx:alpine "/docker-entrypoint.…" About a minute ago Up About a minute 0.0.0.0:80->80/tcp, 0.0.0.0:443->443/tcp nginx_fastapi_sample eb18438efd2c fastapi_sample_app "/fastapi_sample/doc…" About a minute ago Up About a minute 8000/tcp app_fastapi_sample 383b0e46af68 postgres:12.4-alpine "docker-entrypoint.s…" About a minute ago Up About a minute 0.0.0.0:5432->5432/tcp db_fastapi_samplehttps://localhostにアクセスして、

{"message":"Hello World"}が表示されれば完了です。ライブラリ「pydantic」を使用して環境変数(.env)を扱う

.envファイル作成$ touch .envfastapi_sample/.envDEBUG=True DATABASE_URL=postgresql://postgres:postgres@db:5432/db_fastapi_sample「pydatic」を使って環境変数を読み込む設定ファイルを作成

ライブラリ「pydantic」を使うと、.env から値を読み込む処理を簡単に実装できます。

また型に合わせてキャストしてくれたりするので超便利。

os.getenv('DEBUG') == 'True'みたいな気持ち悪い条件式を書かなくてよくなります。(distutils.util.strtobool使えって話ですが、、、)pydanticをインストール

fastapi_sample/requirements.txtpydantic[email]==1.6.1 # 追記したらpip3 installフォルダ「core」を作成、その直下に「config.py」を作成

$ mkdir core $ touch core/config.pyfastapi_sample/core/config.pyimport os from functools import lru_cache from pydantic import BaseSettings PROJECT_ROOT = os.path.dirname(os.path.dirname(os.path.abspath(__file__))) class Environment(BaseSettings): """ 環境変数を読み込むファイル """ debug: bool # .envから読み込んだ値をbool型にキャッシュ database_url: str class Config: env_file = os.path.join(PROJECT_ROOT, '.env') @lru_cache def get_env(): """ 「@lru_cache」でディスクから読み込んだ.envの結果をキャッシュする """ return Environment()alembic(マイグレーションツール)環境の用意 と モデルを用意

何はともあれインストール

requirements.txtに alembic と sqlalchemy 追記してから

pip3 install -r requirements.txtでインストール

(Dockerの手順を踏んでいる人はdocker-compose restart appまたはdocker-compose exec app pip3 install -r requiements.txt)fastapi_samepl/requirements.txtalembic==1.4.2 # 追記 . .. ... psycopg2==2.8.6 # 追記 . .. ... SQLAlchemy==1.3.18 # 追記 SQLAlchemy-Utils==0.36.8 # 追記プロジェクトルート直下にalembic環境を作成する

$ alembic init migrations # Dockerの手順を踏んだ人はdocker-compose exec app alembic init migrationsプロジェクトルートにalembicテンプレートが作成されます。(alembic.ini, migrationsフォルダ)

fastapi_sample(プロジェクトルート) ├── ... ├── .. ├── . ├── alembic.ini ├── migrations │ ├── README │ ├── env.py │ ├── script.py.mako │ └── versions └── ...ベースモデルを用意

まずはベースモデルを実装します。

touch models.pyfastapi_sample/migrations/models.pyfrom sqlalchemy import Column from sqlalchemy.dialects.postgresql import INTEGER, TIMESTAMP from sqlalchemy.ext.declarative import declarative_base, declared_attr from sqlalchemy.sql.functions import current_timestamp Base = declarative_base() class BaseModel(Base): """ ベースモデル """ __abstract__ = True id = Column( INTEGER, primary_key=True, autoincrement=True, ) created_at = Column( 'created_at', TIMESTAMP(timezone=True), server_default=current_timestamp(), nullable=False, comment='登録日時', ) updated_at = Column( 'updated_at', TIMESTAMP(timezone=True), onupdate=current_timestamp(), comment='最終更新日時', ) @declared_attr def __mapper_args__(cls): """ デフォルトのオーダリングは主キーの昇順 降順にしたい場合 from sqlalchemy import desc # return {'order_by': desc('id')} """ return {'order_by': 'id'}ユーザーモデルを用意

モデルはなんでもいいですが、認証編を書くときに使えそうなのでユーザーモデルを作成します。

モジュール分割はあえてしていません。(マイグレーションファイル生成時などで不都合発生して手間なので、しない方がいいかも?)fastapi_sample/migrations/models.pyfrom sqlalchemy import ( BOOLEAN, # 追加 Column INTEGER, TIMESTAMP, VARCHAR, # 追加 ) from sqlalchemy.ext.declarative import declarative_base, declared_attr from sqlalchemy.sql.functions import current_timestamp Base = declarative_base() class BaseModel(Base): ... .. . class User(BaseModel): __tablename__ = 'users' email = Column(VARCHAR(254), unique=True, nullable=False) password = Column(VARCHAR(128), nullable=False) last_name = Column(VARCHAR(100), nullable=False) first_name = Column(VARCHAR(100), nullable=False) is_admin = Column(BOOLEAN, nullable=False, default=False) is_active = Column(BOOLEAN, nullable=False, default=True)env.pyを編集する

fastapi_sample/migrations/env.pyfrom migrations.models import Base # 追加 ... .. . target_metadata = Base.metadata # メタデータをセット ... .. .DBの接続先を変更

モデルを実装したところで、早速マイグレーションを行いたいところです。

が、alembicがプロジェクトテンプレートのままなのでalembic.iniのなかのデータベースURLもテンプレートのままです。fastapi_sample/alembic.ini. .. ... sqlalchemy.url = driver://user:pass@localhost/dbname ... .. .なので勿論alembicのマイグレーションファイル生成コマンドなどは失敗してしまいます。

$ docker-compose exec app alembic revision --autogenerate Traceback (most recent call last): File "/root/local/python-3.8.5/bin/alembic", line 8, in <module> sys.exit(main()) ... (長いので省略) . cls = registry.load(name) File "/root/local/python-3.8.5/lib/python3.8/site-packages/sqlalchemy/util/langhelpers.py", line 267, in load raise exc.NoSuchModuleError( sqlalchemy.exc.NoSuchModuleError: Can't load plugin: sqlalchemy.dialects:driveralembic.iniを直接書き換えるのもいいですが、開発環境やステージング、本番環境でそれぞれ異なるalembic.iniファイルができてしまい気持ち悪いです。

なので、マイグレーションファイル生成時やマイグレート実行時は、alembic.iniのデータベースURLを一時的に.envのDATABASE_URLで書き換えるようにしてみます。

python-dotenvをインストールfastapi_sample/requirements.txtpython-dotenv==0.14.0 # 追記したらインストールする

env.pyを修正fastapi_sample/migrations/env.pyimport os from core.config import PROJECT_ROOT from dotenv import load_dotenv . .. ... # other values from the config, defined by the needs of env.py, # can be acquired: # my_important_option = config.get_main_option("my_important_option") # ... etc. # alembic.iniの'sqlalchemy.url'を.envのDATABASE_URLで書き換える load_dotenv(dotenv_path=os.path.join(PROJECT_ROOT, '.env')) config.set_main_option('sqlalchemy.url', os.getenv('DATABASE_URL')) def run_migrations_offline(): ... .. .再度マイグレーションファイル生成コマンド実行

% docker-compose exec app alembic revision --autogenerate None /fastapi_sample INFO [alembic.runtime.migration] Context impl PostgresqlImpl. INFO [alembic.runtime.migration] Will assume transactional DDL. INFO [alembic.autogenerate.compare] Detected added table 'users' Generating /fastapi_sample/migrations/versions/2bc0a23e563c_.py ... doneマイグレーションファイルを生成できました。

migrations ├── ... ├── ... ├── models.py └── versions └── 2bc0a23e563c_.py # マイグレーションファイルができた。ただ、今のままだとマイグレーションファイルの生成順がパッと見でわからないのと、マイグレーションファイル内に記載してある生成日時(Create Date)がUTCのままなので日本時間に変えたいです。

alembic.iniを修正します。

fastapi_sample/alembic.ini. .. ... [alembic] # path to migration scripts script_location = migrations # ファイルの接頭に「YYYYMMDD_HHMMSS_」がつくようにする # template used to generate migration files file_template = %%(year)d%%(month).2d%%(day).2d_%%(hour).2d%%(minute).2d%%(second).2d_%%(rev)s_%%(slug)s # タイムゾーンを日本時間に # timezone to use when rendering the date # within the migration file as well as the filename. # string value is passed to dateutil.tz.gettz() # leave blank for localtime timezone = Asia/Tokyo ... .. .先ほど生成したマイグレーションファイルを消して、再度マイグレーションファイルを生成します。

migrations ├── ... ├── ... ├── models.py └── versions └── 20201024_200033_8a19c4c579bf_.py # ファイル内のCreate Dateも日本時間になっているマイグレート実行

$ alembic upgrade head # Dockerの手順を踏んだ人はdocker-compose exec app alembic upgrade headちゃんとユーザーテーブルが作成されています。

(alembic_versionはalembicがバージョン管理に使用するテーブルで、自動生成されます)

コンテナ起動時にマイグレートが実行されるようにする

これでコンテナを起動するたびにマイグレートが実行されるようになります。

fastapi_sample/docker/rundevserver.shpip3 install -r requirements.txt alembic upgrade head # 追記 uvicorn main:app\ --reload\ --port 8000\ --host 0.0.0.0\ --log-level debugデータアクセスクラス作成

ベースのデータアクセスクラスを作成

単純な全件取得や1件取得、登録、更新、削除などを記載します。

base.pyに記載しているget_db_session()は後述するリクエストミドルウェアやテストコード実行時などで大変重要な役割を果たします、今は気にしなくて良いです。mkdir crud touch crud/base.pyfastapi_sample/crud/base.pyfrom core.config import get_env from migrations.models import Base from sqlalchemy import create_engine from sqlalchemy.orm import sessionmaker, scoped_session, query from typing import List, TypeVar ModelType = TypeVar("ModelType", bound=Base) connection = create_engine( get_env().database_url, echo=get_env().debug, encoding='utf-8', ) Session = scoped_session(sessionmaker(connection)) def get_db_session() -> scoped_session: yield Session class BaseCRUD: """ データアクセスクラスのベース """ model: ModelType = None def __init__(self, db_session: scoped_session) -> None: self.db_session = db_session self.model.query = self.db_session.query_property() def get_query(self) -> query.Query: """ ベースのクエリ取得 """ return self.model.query def gets(self) -> List[ModelType]: """ 全件取得 """ return self.get_query().all() def get_by_id(self, id: int) -> ModelType: """ 主キーで取得 """ return self.get_query().filter_by(id=id).first() def create(self, data: dict = {}) -> ModelType: """ 新規登録 """ obj = self.model() for key, value in data.items(): if hasattr(obj, key): setattr(obj, key, value) self.db_session.add(obj) self.db_session.flush() self.db_session.refresh(obj) return obj def update(self, obj: ModelType, data: dict = {}) -> ModelType: """ 更新 """ for key, value in data.items(): if hasattr(obj, key): setattr(obj, key, value) self.db_session.flush() self.db_session.refresh(obj) return obj def delete_by_id(self, id: int) -> None: """ 主キーで削除 """ obj = self.get_by_id(id) if obj: obj.delete() self.db_session.flush() return Noneユーザーデータアクセスクラスを作成

touch crud/crud_user.pyfastapi_sample/crud/crud_user.pyfrom crud.base import BaseCRUD from migrations.models import User class CRUDUser(BaseCRUD): """ ユーザーデータアクセスクラスのベース """ model = UserAPI実装

お待たせしました、ようやくAPI実装編です。

API実装前準備

リクエスト情報にDBセッションを格納する依存性注入用(Depends)の関数を実装します。

このFastAPIの依存性注入システムがとても強力で、パラメーターをまとめたりもすることができます。

完全に理解しているわけではないので、申し訳ないのですが詳細は公式ドキュメントを参照してください。mkdir dependencies touch dependencies/__init__.pydependencies/__init__.pyfrom fastapi import Depends, Request from crud.base import get_db_session from sqlalchemy.orm import scoped_session async def set_db_session_in_request( request: Request, db_session: scoped_session = Depends(get_db_session) ): """ リクエストにDBセッションをセットする """ request.state.db_session = db_sessionAPIを実装していくフォルダ作成

mkdir -p api/v1ユーザーの一覧取得API実装

touch api/v1/user.pyfastapi_sample/api/v1/user.pyfrom crud.base import Session from crud.crud_user import CRUDUser from fastapi import Request from fastapi.encoders import jsonable_encoder class UserAPI: """ ユーザーに関するAPI """ @classmethod def gets(cls, request: Request): """ 一覧取得 """ # 依存性注入システムを用いて、リクエスト情報にDBセッションをセットしたので、 # ここで「request.state.db_session」を使用することができる return jsonable_encoder(CRUDUser(request.state.db_session).gets())APIルーター実装

ルーターの

dependencies=[Depends(set_db_session_in_request)]が今後重要な機能を果たしてくれますmkdir -p api/endpoints/v1 touch api/endpoints/v1/user.pyfastapi_sample/api/endpoints/v1/user.pyfrom api.v1.user import UserAPI from dependencies import set_db_session_in_request from fastapi import APIRouter, Depends, Request router = APIRouter() @router.get( '/', dependencies=[Depends(set_db_session_in_request)]) async def gets(request: Request): return UserAPI.gets(request)ルーターをエントリーポイントに登録する

APIルーターを作成

touch api/endpoints/v1/__init__.pyfastapi_sample/api/endpoints/v1/__init__.pyfrom fastapi import APIRouter from api.endpoints.v1 import user api_v1_router = APIRouter() api_v1_router.include_router( user.router, prefix='users', tags=['users'])main.pyを編集

fastapi_sample/main.pyfrom api.endpoints.v1 import api_v1_router # 追記 from fastapi import FastAPI app = FastAPI() app.include_router(api_v1_router, prefix='/api/v1') # 追記 @app.get("/") async def root(): return {"message": "Hello World"}ブラウザからhttps://localhost/docsアクセスすると実装したAPIが表示されているはずです。

登録/更新用にスキーマ(フォーム?)を定義する

mkdir api/schemas touch api/schemas/user.pyfastapi_sample/api/schemas/user.pyfrom pydantic import BaseModel, EmailStr from typing import Optional class BaseUser(BaseModel): email: EmailStr last_name: str first_name: str is_admin: bool class CreateUser(BaseUser): password: str class UpdateUser(BaseUser): password: Optional[str] last_name: Optional[str] first_name: Optional[str] is_admin: bool class UserInDB(BaseUser): class Config: orm_mode = Trueユーザーの登録/更新/削除のAPIを追加

fastapi_sample/api/v1/user.pyfrom api.schemas.user import CreateUser, UpdateUser, UserInDB from crud.crud_user import CRUDUser from fastapi import Request # from fastapi.encoders import jsonable_encoder # 削除 from typing import List class UserAPI: """ ユーザーに関するAPI """ @classmethod def gets(cls, request: Request) -> List[UserInDB]: """ 一覧取得 """ return CRUDUser(request.state.db_session).gets() # jsonable_encoderは使わない @classmethod def create( cls, request: Request, schema: CreateUser ) -> UserInDB: """ 新規登録 """ return CRUDUser(request.state.db_session).create(schema.dict()) @classmethod def update( cls, request: Request, id: int, schema: UpdateUser ) -> UserInDB: """ 更新 """ crud = CRUDUser(request.state.db_session) obj = crud.get_by_id(id) return CRUDUser(request.state.db_session).update(obj, schema.dict()) @classmethod def delete(cls, request: Request, id: int) -> None: """ 削除 """ return CRUDUser(request.state.db_session).delete_by_id(id)ユーザーのAPIルーターを編集

fastapi_sample/api/endpoints/v1/user.pyfrom api.schemas.user import CreateUser, UpdateUser, UserInDB from api.v1.user import UserAPI from dependencies import set_db_session_in_request from fastapi import APIRouter, Depends, Request from typing import List router = APIRouter() @router.get( '/', response_model=List[UserInDB], # response_modelを追加 dependencies=[Depends(set_db_session_in_request)]) def gets(request: Request) -> List[UserInDB]: """ 一覧取得 """ return UserAPI.gets(request) @router.post( '/', response_model=UserInDB, dependencies=[Depends(set_db_session_in_request)]) def create(request: Request, schema: CreateUser) -> UserInDB: """ 新規登録 """ return UserAPI.create(request, schema) @router.put( '/{id}/', response_model=UserInDB, dependencies=[Depends(set_db_session_in_request)]) def update(request: Request, id: int, schema: UpdateUser) -> UserInDB: """ 更新 """ return UserAPI.update(request, id, schema) @router.delete( '/{id}/', dependencies=[Depends(set_db_session_in_request)]) def delete(request: Request, id: int) -> None: """ 削除 """ return UserAPI.delete(request, id)ブラウザからアクセスして確認

routerに

response_modelを指定すると、DBから取得したオブジェクトのJSONシリアライズを開発者が明示的に実装する必要がなくなります。(jsonable_encoder()を使わなくて良くなったのはこれのおかげ)

また、swagger-UI上にも反映してくれます。

※一覧取得のレスポンス

リクエストミドルウェアを実装する

さて、APIは実行できましたが、DBセッションのコミット実行していないので登録/更新/削除を実行してもDBが変更されません。

変更をDBに反映させるため、以下のようなリクエストミドルウェアを実装して適用します。

・リクエストが完了したらDBセッションコミットしてからDBセッション破棄

・エラー発生時はロールバックしてからDBセッション破棄mkdir middleware touch middleware/__init__.pyfastapi_sample/middleware/__init__.pyfrom fastapi import Request, Response from starlette.middleware.base import BaseHTTPMiddleware class HttpRequestMiddleware(BaseHTTPMiddleware): async def dispatch(self, request: Request, call_next) -> Response: try: response = await call_next(request) # 予期せぬ例外 except Exception as e: print(e) request.state.db_session.rollback() raise e # 正常終了時 else: request.state.db_session.commit() return response # DBセッションの破棄は必ず行う finally: request.state.db_session.remove()エントリーポイントにミドルウェアを適用する

fastapi_sample/main.pyfrom api.endpoints.v1 import api_v1_router from fastapi import FastAPI from middleware import HttpRequestMiddleware # 追加 app = FastAPI() app.include_router(api_v1_router, prefix='/api/v1') # ミドルウェアの設定 app.add_middleware(HttpRequestMiddleware) # 追加 @app.get("/") async def root(): return {"message": "Hello World"}CRUD実行で確認

テストコード実装編

CRUDを実装できたので、次はテストコードを実装していきます。

とはいえ、単純にテストコードからAPIを実行してしまうと、DBに登録・更新・削除が実行されるため、テスト実行ごとに結果が変わってしまう可能性があります。

それを防ぐため、テスト関数ごとにクリーンなDBを作成し、そのDBを使用してテストするようにしたいと思います。pytestをインストール

fastapi_sample/requirements.txtpytest==6.1.0 # 追記したらrequirements.txtをインストールし直すのを忘れずにテスト用のDB接続情報を環境変数に追加

fastapi_sample/.envDEBUG=True DATABASE_URL=postgresql://postgres:postgres@db:5432/db_fastapi_sample TEST_DATABASE_URL=postgresql://postgres:postgres@db:5432/test_db_fastapi_sample # 追加fastapi_sample/core/config.pyclass Environment(BaseSettings): """ 環境変数を読み込むファイル """ debug: bool database_url: str test_database_url: str # 追加テストコード実装用のフォルダ作成

mkdir testsAPIのベーステストクラスを作成

touch tests/base.pyfastapi_sample/tests/base.pyimport psycopg2 from core.config import get_env from crud.base import get_db_session from fastapi.testclient import TestClient from main import app from migrations.models import Base from psycopg2.extensions import ISOLATION_LEVEL_AUTOCOMMIT from sqlalchemy import create_engine from sqlalchemy.orm import scoped_session, sessionmaker from sqlalchemy_utils import database_exists, drop_database test_db_connection = create_engine( get_env().test_database_url, encoding='utf8', pool_pre_ping=True, ) class BaseTestCase: def setup_method(self, method): """ 前処理 """ # テストDB作成 self.__create_test_database() self.db_session = self.get_test_db_session() # APIクライアントの設定 self.client = TestClient(app, base_url='https://localhost',) # DBをテスト用のDBでオーバーライド app.dependency_overrides[get_db_session] = \ self.override_get_db def teardown_method(self, method): """ 後処理 """ # テストDB削除 self.__drop_test_database() # オーバーライドしたDBを元に戻す app.dependency_overrides[self.override_get_db] = \ get_db_session def override_get_db(self): """ DBセッションの依存性オーバーライド関数 """ yield self.db_session def get_test_db_session(self): """ テストDBセッションを返す """ return scoped_session(sessionmaker(bind=test_db_connection)) def __create_test_database(self): """ テストDB作成 """ # テストDBが削除されずに残ってしまっている場合は削除 if database_exists(get_env().test_database_url): drop_database(get_env().test_database_url) # テストDB作成 _con = \ psycopg2.connect('host=db user=postgres password=postgres') _con.set_isolation_level(ISOLATION_LEVEL_AUTOCOMMIT) _cursor = _con.cursor() _cursor.execute('CREATE DATABASE test_db_fastapi_sample') # テストDBにExtension追加 _test_db_con = psycopg2.connect( 'host=db dbname=test_db_fastapi_sample user=postgres password=postgres' ) _test_db_con.set_isolation_level(ISOLATION_LEVEL_AUTOCOMMIT) # テストDBにテーブル追加 Base.metadata.create_all(bind=test_db_connection) def __drop_test_database(self): """ テストDB削除 """ drop_database(get_env().test_database_url)ポイントはこのDBオーバーライド部分です。

アプリケーションが参照するDBをテストDBに切り替えています。# DBをテスト用のDBでオーバーライド app.dependency_overrides[get_db_session] = self.override_get_dbこうすることで、APIやミドルウェアで使用している「request.state.db_session」もテストDBに切り替えることができます。

一覧取得のテストコードを実装してみる

requirements.txtrequests==2.24.0 # 追記したら必ずrequirements.txtをインストールmkdir -p tests/api/v1 touch tests/api/v1/test_user.py # "test_"を接頭に付けないとpytest実行時にスルーされてしまうので必ずつけるfastapi_sample/tests/api/v1/test_user.pyimport json from crud.crud_user import CRUDUser from fastapi import status from tests.base import BaseTestCase class TestUserAPI(BaseTestCase): """ ユーザーAPIのテストクラス """ TEST_URL = '/api/v1/users/' def test_gets(self): """ 一覧取得のテスト """ # テストユーザー登録 test_data = [ { 'email': 'test1@example.com', 'password': 'password', 'last_name': 'last_name', 'first_name': 'first_name', 'is_admin': False }, { 'email': 'test2@example.com', 'password': 'password', 'last_name': 'last_name', 'first_name': 'first_name', 'is_admin': True }, { 'email': 'test3@example.com', 'password': 'password', 'last_name': 'last_name', 'first_name': 'first_name', 'is_admin': False }, ] for data in test_data: CRUDUser(self.db_session).create(data) self.db_session.commit() response = self.client.get(self.TEST_URL) # ステータスコードの検証 assert response.status_code == status.HTTP_200_OK # 取得した件数の検証 response_data = json.loads(response._content) assert len(response_data) == len(test_data) # レスポンスの内容を検証 expected_data = [{ 'email': item['email'], 'last_name': item['last_name'], 'first_name': item['first_name'], 'is_admin': item['is_admin'], } for i, item in enumerate(test_data, 1)] assert response_data == expected_dataテスト実行

pytest # Dockerの手順を踏んだ方は、docker-compose exec app pytest # print()文の出力を確認したい場合は、pytest -v --capture=no% docker-compose exec app pytest -v --capture=no ================================================================================================== test session starts =================================================================================================== platform linux -- Python 3.8.5, pytest-6.1.0, py-1.9.0, pluggy-0.13.1 -- /root/local/python-3.8.5/bin/python3.8 cachedir: .pytest_cache rootdir: /fastapi_sample collected 1 item tests/api/v1/test_user.py::TestUserAPI::test_gets PASSED # 成功 ==================================================================================================== warnings summary ==================================================================================================== <string>:2 <string>:2: SADeprecationWarning: The mapper.order_by parameter is deprecated, and will be removed in a future release. Use Query.order_by() to determine the ordering of a result set. -- Docs: https://docs.pytest.org/en/stable/warnings.htmlテストも無事成功しました。

データベースを確認してみましょう。

API実装時に試しに登録したデータしかありません。

テスト用のDBに切り替えてのテスト実行は成功したようです!ローカルDBを汚さず、かつ テストケースごとのテストデータも干渉することなくテストコードを実行することができるようになりました。

やったね。リクエストミドルウェア実装後、swagger-UI表示時「Internal Server Error」になる

swagger-UI表示時、「request.state」に「db_session」が存在しないため、Key Errorで「Internal Server Error」となります。

手取り早く直したい場合

リクエストミドルウェアの「request.state.db_session」を以下のように書き換えます。

fastapi_sample/middleware/__init__.pyfrom crud.base import Session # 追加 from fastapi import Request, Response from starlette.middleware.base import BaseHTTPMiddleware class HttpRequestMiddleware(BaseHTTPMiddleware): async def dispatch(self, request: Request, call_next) -> Response: try: response = await call_next(request) # 予期せぬ例外 except Exception as e: print(e) getattr(request.state, 'db_session', Session).rollback() # これに書き換え raise e # 正常終了時 else: getattr(request.state, 'db_session', Session).commit() # これに書き換え return response # DBセッションの破棄は必ず行う finally: getattr(request.state, 'db_session', Session).remove() # これに書き換えリクエストミドルウェアは触りたくない場合

swagger-uiで表示するエンドポイントを全てオーバーライドするしかありません。

FastAPIクラスをオーバーライド

touch core/fastapi.pyfastapi_sample/core/fastapi.pyimport fastapi from fastapi import Request from fastapi.exceptions import RequestValidationError from fastapi.exception_handlers import ( http_exception_handler, request_validation_exception_handler, ) from fastapi.openapi.docs import ( get_redoc_html, get_swagger_ui_html, get_swagger_ui_oauth2_redirect_html, ) from fastapi.responses import JSONResponse, HTMLResponse from starlette.exceptions import HTTPException class FastAPI(fastapi.FastAPI): def setup(self) -> None: if self.openapi_url: urls = (server_data.get("url") for server_data in self.servers) server_urls = {url for url in urls if url} async def openapi(req: Request) -> JSONResponse: root_path = req.scope.get("root_path", "").rstrip("/") if root_path not in server_urls: if root_path and self.root_path_in_servers: self.servers.insert(0, {"url": root_path}) server_urls.add(root_path) return JSONResponse(self.openapi(self, req)) # 書き換えているのはこの部分だけ self.add_route(self.openapi_url, openapi, include_in_schema=False) if self.openapi_url and self.docs_url: async def swagger_ui_html(req: Request) -> HTMLResponse: root_path = req.scope.get("root_path", "").rstrip("/") openapi_url = root_path + self.openapi_url oauth2_redirect_url = self.swagger_ui_oauth2_redirect_url if oauth2_redirect_url: oauth2_redirect_url = root_path + oauth2_redirect_url return get_swagger_ui_html( openapi_url=openapi_url, title=self.title + " - Swagger UI", oauth2_redirect_url=oauth2_redirect_url, init_oauth=self.swagger_ui_init_oauth, ) self.add_route( self.docs_url, swagger_ui_html, include_in_schema=False ) if self.swagger_ui_oauth2_redirect_url: async def swagger_ui_redirect(req: Request) -> HTMLResponse: return get_swagger_ui_oauth2_redirect_html() self.add_route( self.swagger_ui_oauth2_redirect_url, swagger_ui_redirect, include_in_schema=False, ) if self.openapi_url and self.redoc_url: async def redoc_html(req: Request) -> HTMLResponse: root_path = req.scope.get("root_path", "").rstrip("/") openapi_url = root_path + self.openapi_url return get_redoc_html( openapi_url=openapi_url, title=self.title + " - ReDoc" ) self.add_route(self.redoc_url, redoc_html, include_in_schema=False) self.add_exception_handler(HTTPException, http_exception_handler) self.add_exception_handler( RequestValidationError, request_validation_exception_handler )swagger-ui用のルーターを用意

touch api/endpoints/swagger_ui.pyfastapi_sample/api/endpoints/swagger_ui.pyfrom core.fastapi import FastAPI from crud.base import Session from dependencies import set_db_session_in_request from fastapi import APIRouter, Depends, Request from fastapi.openapi.docs import get_redoc_html, get_swagger_ui_html from fastapi.openapi.utils import get_openapi swagger_ui_router = APIRouter() @swagger_ui_router.get( '/docs', include_in_schema=False, dependencies=[Depends(set_db_session_in_request)]) async def swagger_ui_html(request: Request): return get_swagger_ui_html( openapi_url=FastAPI().openapi_url, title=FastAPI().title, oauth2_redirect_url=FastAPI().swagger_ui_oauth2_redirect_url, ) @swagger_ui_router.get( '/redoc', include_in_schema=False, dependencies=[Depends(set_db_session_in_request)]) async def redoc_html(request: Request): return get_redoc_html( openapi_url=FastAPI().openapi_url, title=FastAPI().title + " - ReDoc", ) def openapi(app: FastAPI, request: Request): request.state.db_session = Session if app.openapi_schema: return app.openapi_schema openapi_schema = get_openapi( title="FastAPI", version="0.1.0", routes=app.routes, ) app.openapi_schema = openapi_schema return app.openapi_schemaエントリーポイント修正

fastapi_sample/main.pyfrom api.endpoints.swagger_ui import openapi, swagger_ui_router from api.endpoints.v1 import api_v1_router from core.config import get_env # from fastapi import FastAPI from core.fastapi import FastAPI # オーバーライドしたFastAPIクラスを使用する from middleware import HttpRequestMiddleware app = FastAPI( docs_url=None, # Noneを設定しないとswagger-uiのルーターで定義したものに変わらない redoc_url=None, # Noneを設定しないとswagger-uiのルーターで定義したものに変わらない ) app.include_router(api_v1_router, prefix='/api/v1') # ミドルウェアの設定 app.add_middleware(HttpRequestMiddleware) # @app.get("/") # async def root(): # return {"message": "Hello World"} # swagger-uiは開発時のみ表示されるようにする if get_env().debug: app.include_router(swagger_ui_router) app.openapi = openapi無事swagger-uiのエラーが解消され、表示されるようになりました。

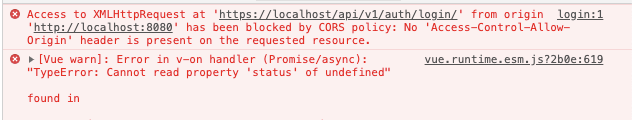

【オマケ①】CORS問題を回避

このままだと、フロントエンドからのAPI呼び出し時にCORSエラー発生してしまいます。

この問題を回避するため、CORSミドルウェアを実装します。

.envと環境変数を扱うクラスを編集fastapi_sample/.envALLOW_HEADERS='["*"]' # 追加 ALLOW_ORIGINS='["*"]' # 追加 DEBUG=True DATABASE_URL=postgresql://postgres:postgres@db:5432/db_fastapi_sample TEST_DATABASE_URL=postgresql://postgres:postgres@db:5432/test_db_fastapi_samplefastapi_sample/core/config.pyclass Environment(BaseSettings): """ 環境変数を読み込むファイル """ allow_headers: list # 追加 allow_origins: list # 追加 ... .. .CORSミドルウェアを実装・エントリポイントに適用

fastapi_sample/middleware/__init__.pyfrom core.config import get_env # 追加 from crud.base import Session from fastapi import Request, Response from starlette.middleware import cors # 追加 from starlette.middleware.base import BaseHTTPMiddleware from starlette.types import ASGIApp # 追加 class CORSMiddleware(cors.CORSMiddleware): """ CORS問題を回避するためのミドルウェア """ def __init__(self, app: ASGIApp) -> None: super().__init__( app, allow_origins=get_env().allow_origins, allow_methods=cors.ALL_METHODS, allow_headers=get_env().allow_headers, allow_credentials=True, ) class HttpRequestMiddleware(BaseHTTPMiddleware): ... .. .fastapi_sample/main.pyfrom api.endpoints.swagger_ui import openapi, swagger_ui_router from api.endpoints.v1 import api_v1_router from core.config import get_env from core.fastapi import FastAPI from middleware import ( CORSMiddleware, # 追加 HttpRequestMiddleware ) ... .. . # ミドルウェアの設定 # ・ミドルウェアは 後 に追加したものが先に実行される # ・CORSMiddlewareは必ず一番 後 に追加すること # ・ミドルウェアを追加する場合はCORSMiddleware と ProcessRequestMiddlewareより 前 に追加すること app.add_middleware(HttpRequestMiddleware) app.add_middleware(CORSMiddleware) # 追加 ... .. .ポイントはミドルウェアを追加する順番です。

後に書いたミドルウェアが先に実行されるので、CORSミドルウェアは一番最後に書きましょう。

無事、フロントエンドのCORSエラーは回避することができるようになりました。

(文字列"ログイン成功"を返すだけのAPIを作成してフロントエンドから実行)

【オマケ②】カスタム例外

HTTPExceptionを継承してカスタム例外を作成してみます。

エラーレスポンスはこんな感じで、エラーコードとエラーメッセージを複数返せるような形式します。detail: [ { error_code: 'エラーコード', error_message: 'エラーメッセージ' }, { error_code: 'エラーコード', error_message: 'エラーメッセージ' }, { ... }, { ... }, ]メッセージを管理するiniファイルを作成

touch core/error_messages.inifastapi_sample/core/error_messages.ini[messages] INTERNAL_SERVER_ERROR=システムエラーが発生しました。管理者に問い合わせてください FAILURE_LOGIN=ログイン失敗カスタム例外を実装するフォルダ作成

mkdir exception touch exception/__init__.py touch exception/error_messages.pyエラーコードとエラーメッセージの管理クラス

fastapi_sample/exception/error_messages.pyimport os from configparser import ConfigParser from core.config import PROJECT_ROOT from functools import lru_cache MESSAGES_INI = ConfigParser() MESSAGES_INI.read( os.path.join(PROJECT_ROOT, 'core/error_messages.ini'), 'utf-8' ) @lru_cache def get(key: str, *args): return MESSAGES_INI.get('messages', key).format(*args) INTERNAL_SERVER_ERROR = 'INTERNAL_SERVER_ERROR' FAILURE_LOGIN = 'FAILURE_LOGIN'fastapi_sample/exception/__init__.pyfrom fastapi import status, HTTPException from exception import error_messages class ApiException(HTTPException): """ API例外 """ default_status_code = status.HTTP_400_BAD_REQUEST def __init__( self, *errors, status_code: int = default_status_code ) -> None: self.status_code = status_code self.detail = [ { 'error_code': error['error_code'], 'error_msg': error_messages.get( error['error_code'], *error['msg_params']), } for error in list(errors) ] super().__init__(self.status_code, self.detail) def create_error(error_code: str, *msg_params) -> dict: """ エラー生成 """ return { 'error_code': error_code, 'msg_params': msg_params, }カスタム例外をスローする

fastapi_sample/api/v1/auth.pyfrom fastapi import Request from exception import ( ApiException, create_error, error_messages, ) class AuthAPI: """ 認証に関するAPI """ @classmethod def login(cls, request: Request): """ ログインAPI """ # カスタム例外をスロー raise ApiException( create_error(error_messages.FAILURE_LOGIN) ) return 'ログイン成功'リクエストミドルウェアを修正する

fastapi_sample/middleware/__init__.pyfrom exception import ApiException # 追加 from fastapi import Request, Response from starlette.middleware.base import BaseHTTPMiddleware class HttpRequestMiddleware(BaseHTTPMiddleware): async def dispatch(self, request: Request, call_next) -> Response: try: response = await call_next(request) # アプリケーション例外 except ApiException as ae: # 追加 request.state.db_session.rollback() raise ae # 追加 except Exception as e: request.state.db_session.rollback() raise e else: request.state.db_session.commit() return response finally: request.state.db_session.remove()▼フロント側(エラーレスポンスを確認したいだけなのでスルーでOKです)

sample.jsaxios.interceptors.response.use( response => { return response; }, error => { // エラーレスポンスをコンソール表示 console.log(error.response); ... .. .カスタム例外がスローされ、フロント側でエラーレスポンスを確認することができました。

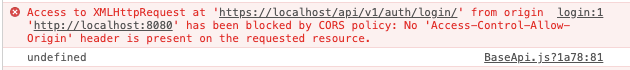

システムエラーについて

アプリが意図的に返す例外は問題ないですが、意図せぬ例外(システムエラー)はどうでしょうか。

fastapi_sample/api/v1/auth.pyfrom fastapi import Request class AuthAPI: """ 認証に関するAPI """ @classmethod def login(cls, request: Request): """ ログインAPI """ result = 1 / 0 # 0除算でエラー return result

結果はCORSエラーが返却された上に、エラーレスポンス(error.response)の中身がundefinedです。

(CORSエラーは多分エラーの形式が不正だから・・・??)

システム例外用のカスタムExceptionを作成

fastapi_sample/exception/__init__.pyimport traceback # 追加 from fastapi import status, HTTPException from exception import error_messages class ApiException(HTTPException): ... .. . class SystemException(HTTPException): """ システム例外 """ def __init__(self, e: Exception) -> None: self.exc = e self.stack_trace = traceback.format_exc() self.status_code = status.HTTP_500_INTERNAL_SERVER_ERROR self.detail = [ { 'error_code': error_messages.INTERNAL_SERVER_ERROR, 'error_msg': error_messages.get( error_messages.INTERNAL_SERVER_ERROR) } ] super().__init__(self.status_code, self.detail)リクエストミドルウェアを修正

fastapi_sample/middleware/__init__.pyfrom exception import ( ApiException, SystemException, # 追加 ) from fastapi import Request, Response from fastapi.responses import JSONResponse # 追加 from starlette.middleware.base import BaseHTTPMiddleware class HttpRequestMiddleware(BaseHTTPMiddleware): async def dispatch(self, request: Request, call_next) -> Response: try: response = await call_next(request) except ApiException as ae: request.state.db_session.rollback() # アプリケーション例外もシステム例外に合わせてResponseを返却する形式に変える return JSONResponse( se.detail, status_code=se.status_code) except Exception as e: request.state.db_session.rollback() se = SystemException(e) # カスタムシステム例外に変換 # raise seとしても、フロント側のエラーレスポンスはなぜか"undefined"のままなのでResponseを返却する # API例外と同じくHTTPExceptionを継承しているのに何故・・・∑(゚Д゚) # raise se return JSONResponse( se.detail, status_code=se.status_code) else: request.state.db_session.commit() return response finally: request.state.db_session.remove()フロント側でシステムエラーのエラーレスポンスを受け取ることができました。

終わり

FastAPIでCRUDを実装してみました。

フルスタックフレームワークのDjango(RestはDRF)ばかり使っていたせいで、初め「なんだこの使いづらいフレームワークは・・・」とか思っていましたが、今ではもうDjangoよりFastAPI派になってしまいました。

ガシガシ環境周りのコードを自分で実装できて楽しいですし、何より成長に繋がりました。

公式ドキュメントを読みきれていないので、他にもいい方法はあるかと思いますので、

コメントでこっそり教えてもらえると嬉しいです( ´ノω`)

私が所属しているFabeee株式会社はお仕事 と 一緒に働くお仲間を随時募集しております!!!!(宣伝)

- 投稿日:2020-10-24T22:12:37+09:00

Pythonで型を極める【Python 3.9対応】

はじめに

みなさん。Pythonで型書いてますか?最近は型の重要性を再認識しているので、皆さんにもぜひPythonで型を書いて頂きたと思ってこの記事を書きました。

注意事項として今回の記事では下記の事項については言及しません。

- 型チェックツールの導入方法(mypy,pyrightなど)

今回の内容は以前の書いた記事の補足内容となっていますので、以前の記事ももしよければ参照ください。

そもそもPythonでなぜ型を書くのか?

Pythonは動的型付き言語なので、型を書かなくてもプログラムは動きます。型を書かないことで、コードの量は少なくなりますし、初学者にとっても習得しやすい言語となっていることはメリットかと思います。

ただし、ある程度の行数のコードを書く場合、プログラムを複数人でメンテナンスする場合、型がないと以下の様な問題が発生する。

- 関数を見ただけでは、返り値がどのようなものか分からない

- 変数に想定外の値が代入されていても分からない

なので、プログラムを長期にわたって保守するという観点からみると、型がある方が優位性があると思います。

例えば、以下のような関数がある場合を考えます。

def add(a, b): """引数を足した結果を返す""" return a + b def add_type(a: int, b: int) -> int: """引数を足した結果を返す""" return a + b同じ内容の関数ですが、片方は型があり、もう片方は型がありません。

実際に以下のように使うことができますが、関数の作成者は文字列が入ることを想定していなかった場合、型があるadd_type関数の方ではエディタでエラーが表示されます。print(add('1', '2')) print(add_type('1', '2'))関数の作成者と利用者が必ずしも同じとは限りませんし、自分で作成した関数でも時間がたてば内容を忘れます。型をつけることで自分が想定したとおりに関数を利用してもらうことが期待できます。

型入門

組み込み型(list,dict,tuple)

listなどについてはPython3.8までと3.9で書き方が異なります。従来のtypingを使う方法が非推奨になり、組み込み型を利用する方法が推奨になっています。

Python3.8の場合

from typing import Dict, List, Tuple val_e: Dict[str, int] = {'size': 12, 'age': 24} val_f: List[str] = ['taro', 'jiro'] val_g: Tuple[str, int] = ('name', 12)Python3.9の場合

val_e: dict[str, int] = {'size': 12, 'age': 24} val_f: list[str] = ['taro', 'jiro'] val_g: tuple[str, int] = ('name', 12)Finalについて

Python3.8からFinalがデフォルトで使用できるようになってます。定数(再代入不可)を定義することで、再代入されないようにすることができます。

from typing import Final TABLE_NAME: Final[str] = 'sample'再代入しようとするとエラーが表示されます。

定数にはtupleを積極的に使う

listとtupleは同じような機能があるので、ついついlistを使いがちですが、tupleの方がメリットが多い場合があるので紹介します。