- 投稿日:2020-08-12T23:25:22+09:00

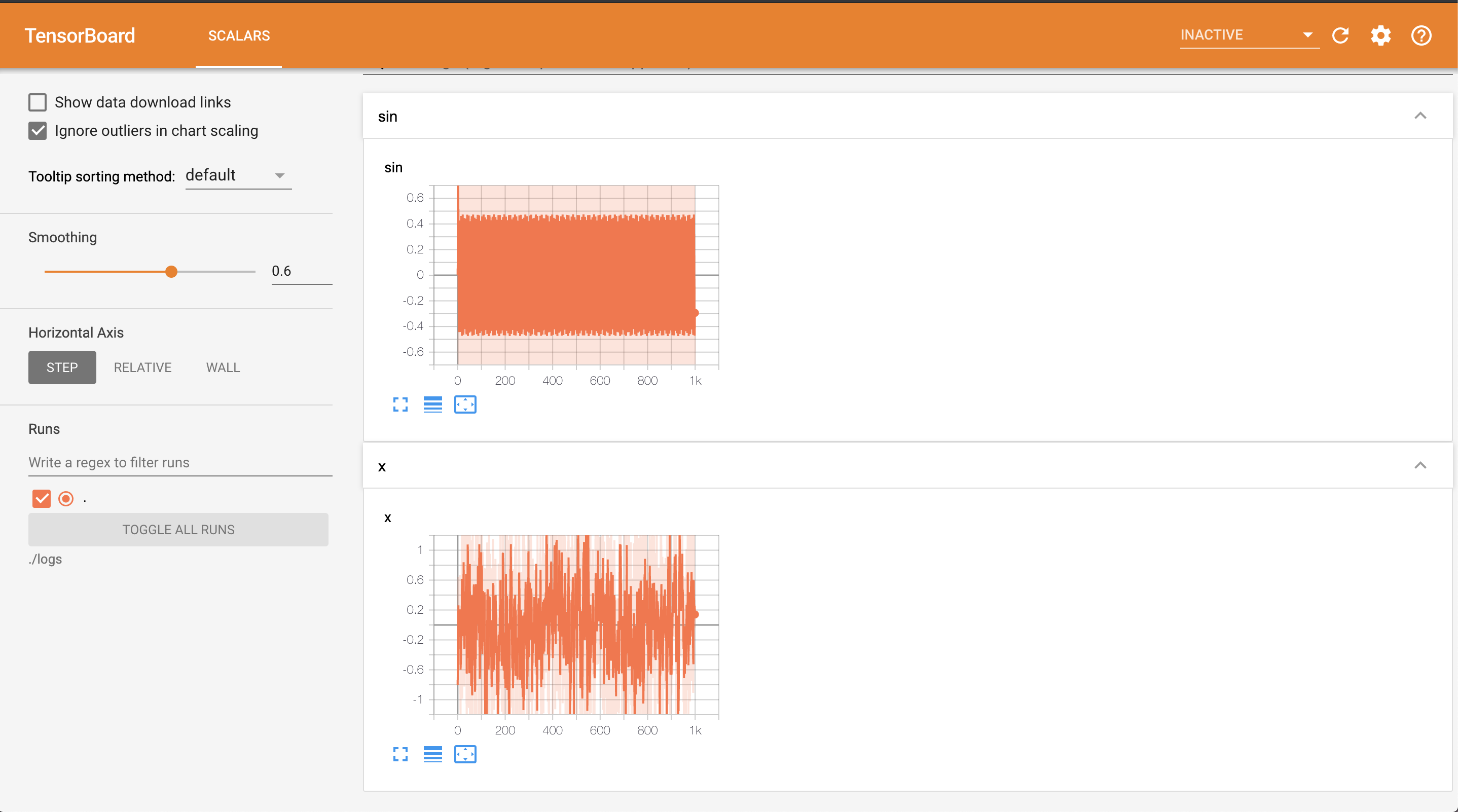

機械学習の可視化ツールTensorboardを使ってみた

はじめに

Tensorboardを初めて使いグラフを書きその便利さに感動したので、共有します。

Deep LearningのフレームワークはPyTorchを使用しました。インストール

Anacondaを使っているので以下のコマンドでTensorboardをインストールします。

conda install tensorboardコーディング

tb.pyimport numpy as np from torch.utils.tensorboard import SummaryWriter#グラフを書くSummaryWriterをimport np.random.seed(1000) x = np.random.randn(1000) writer = SummaryWriter(log_dir="./logs")#インスタンス生成 保存するディレクトリも指定 for i in range(1000): writer.add_scalar("x", x[i], i)#値を書き込む writer.add_scalar("sin", np.sin(i), i) writer.close()#閉じるファイル名をtensorboard.pyにするとmoduleと被りImportErrorになるので注意しましょう。

解説

簡単にいうと、上のコードでは、ランダムな値を持つ配列とsin関数をプロットしています。

SummaryWriterをimport

from torch.utils.tensorboard import SummaryWriter

Tensorboardでグラフの描画に必要なmoduleであるSummaryWriterをimportします。インスタンス生成

writer = SummaryWriter(log_dir="./logs")

これはカレントディレクトリにlogsディレクトリを作成し、そのlogsの中にTensorboard用のファイルが保存されます。値を代入

writer.add_scalar("x", x[i], i)で配列の値を入れます。

writer.add_scalar(tags, scalar_value, global_step)となっており、tagsでグラフの名前を指定して、scalar_valueで保存する値を代入、global_stepでグラフの横軸の間隔を指定します。閉じる

writer.close()で最後に閉じましょう。グラフをみる

tb.pyの実行

上記のコードを実行しましょう。グラフが描画されます。

python tb.pyグラフをみる

以下のコマンドを実行しましょう。

--logdir=""で保存したディレクトリを指定しましょう。

今回は./logsです。tensorboard --logdir="./logs"そうすると、以下の文がターミナルに出力されます。

TensorBoard 2.2.1 at http://localhost:8000/ (Press CTRL+C to quit)ローカルサーバーが立ち上がるので、ブラウザに

http://localhost:8000/と打ちましょう。chromeでみると、グラフが綺麗にプロットしていることがわかります。

ssh先のグラフをみる

Deep Learningのコードは計算量が多くローカルPC(手元のPC)では莫大な時間がかかるので、

研究室にあるサーバーのGPUにsshしてサーバー上でコードを回すことがデフォルトです。

では、そういう場合はリモートサーバーで描画したグラフをローカルPCでどうやってみるのでしょうか?リモートサーバーにsshする

sshをする時に、-Lオプションを用いてクライアント(ローカルPC)のlocalhost:9000をリモートサーバーのユーザ名@サーバーのIPアドレス:8000に繋げます。

@ローカルPCssh ユーザ名@サーバーのIPアドレス -L 9000:localhost:8000リモートサーバーでtb.pyの実行

sshしたリモートサーバーでグラフを描画するコードを実行しましょう。

@リモートサーバーpython tb.pyTensorboardの実行

sshしたリモートサーバーでグラフをみるためのコマンドを実行しましょう。

sshした際にローカルPCに繋いだポートは8000なので、--portオプションで8000を指定して実行しましょう。@リモートサーバーtensorboard --logdir="./logs" --port 8000以下のような文が出力されます。

@リモートサーバーTensorBoard 2.2.1 at http://localhost:8000/ (Press CTRL+C to quit)グラフをみる

さっきは

http://localhost:8000/をブラウザに入力したら、グラフがみれましたが今回は見れません。今回はリモートサーバーのポート8000とローカルPCのポート9000を繋げたので、

ローカルPCのブラウザでhttp://localhost:9000/と入力すれば、さっきと同じグラフが見れます。まとめ

PyTorchでTensorboardを用いてグラフを描画しました。

また、ssh先のリモートサーバーでまわしたコードのグラフをローカルPCでみる方法を紹介しました。

私もこのTensorboardとssh -Lを利用してDeep Learningに活用していきたいと思います。

- 投稿日:2020-08-12T23:14:19+09:00

【Python】PDFからコピーした改行コードだらけのテキストを上手いこと整形する

はじめに

もともとは前々回、前回の記事

【Python】英文PDF(に限らないけど)をDeepLやGoogle翻訳で自動で翻訳させてテキストファイルにしてしまおう。

続【Python】英文PDF(に限らないけど)をDeepLやGoogle翻訳で自動で翻訳させてテキストファイル、いやHTMLにしてしまおう。で使用するために書いたものですが、役に立ちそうなので別途紹介する次第です。

PDFからコピーしたテキストの問題点

PDFについての詳しい知識は持ち合わせていないのですが、

PDF内ではテキストが細かいパーツに分割されて書き込んであるようで、コピーしたテキストにもPDFでの表示の通りの位置に改行コードが含まれます。例えば、PDFで

$$ABC.\\DFE.\\GHI.$$

のような表示の場合、コピーしたテキストは、

$$ABC.{\r\n}DEF.{\r\n}GHI.$$

といった具合です。(上の例はWindows系の場合)

だったらその改行コードを消して文章を繋げればいいじゃないかということで、

$$ABC.DEF.GHI.$$

このようにすると、この例の場合、ピリオドがあるのでそれぞれの文章が混ざることなく済んでいます。

ところがこれで全て解決するかと言うと、そんなに単純な話ではないのです。以下のような場合はどうでしょう

$$1. Introduction\\ABCDEF.\\GHIJKL.\\MNOPQR.$$

単純に改行コードを消すだけだと、

$$1. IntroductionABCDEF.GHIJKL.MNOPQR.$$

となりピリオドのない1行目と2行目の区別がつかなくなってしまいました。

つまり問題となるのは、

見出しなどといったピリオドのような切れ目の目印が必ずしも付かないパーツを、

文章と改行コードしかヒントの存在しないコピーしてきたテキストから如何にして推測し、分解するか。

という点です。やったこと

- 改行コードで分割する

- 空行を消す

- 分割された 注目している文章と次の文章との文字数の差から、本文か見出し文か推測する

- 次の文章の1文字目が小文字かどうかで判断する

- すべて大文字の場合、見出し文と判断する

- 数字(アラビア数字、ローマ数字)+.(ピリオド)が頭についていたら見出し文と判断する

- 注目している文章と次の文章との文字数の差が大きかった場合でも、次の文章ののほうが短く、かつピリオド(または句点)がついていた場合、連続する文と判断する

- 括弧が閉じていない限り連続する文と判断する。

などといった方法を採用しました。

結構シンプルですが大抵の文章は・見出し

・段落

・文章のいずれかの単位で分割する事ができる関数が出来上がりました。

コード

import re import unicodedata def len_(text): cnt = 0 for t in text: if unicodedata.east_asian_width(t) in "FWA": cnt += 2 else: cnt += 1 return cnt def textParser(text, n=30, bracketDetect=True): text = text.splitlines() sentences = [] t = "" bra_cnt = ket_cnt = bra_cnt_jp = ket_cnt_jp = 0 for i in range(len(text)): if not bool(re.search("\S", text[i])): continue if bracketDetect: bra_cnt += len(re.findall("[\((]", text[i])) ket_cnt += len(re.findall("[\))]", text[i])) bra_cnt_jp += len(re.findall("[「「『]", text[i])) ket_cnt_jp += len(re.findall("[」」』]", text[i])) if i != len(text) - 1: if bool(re.fullmatch(r"[A-Z\s]+", text[i])): if t != "": sentences.append(t) t = "" sentences.append(text[i]) elif bool( re.match( "(\d{1,2}[\.,、.]\s?(\d{1,2}[\.,、.]*)*\s?|I{1,3}V{0,1}X{0,1}[\.,、.]|V{0,1}X{0,1}I{1,3}[\.,、.]|[・•●])+\s", text[i])) or re.match("\d{1,2}.\w", text[i]) or ( bool(re.match("[A-Z]", text[i][0])) and abs(len_(text[i]) - len_(text[i + 1])) > n and len_(text[i]) < n): if t != "": sentences.append(t) t = "" sentences.append(text[i]) elif ( text[i][-1] not in ("。", ".", ".") and (abs(len_(text[i]) - len_(text[i + 1])) < n or (len_(t + text[i]) > len_(text[i + 1]) and bool( re.search("[。\..]\s\d|..[。\..]|.[。\..]", text[i + 1][-3:]) or bool(re.match("[A-Z]", text[i + 1][:1])))) or bool(re.match("\s?[a-z,\)]", text[i + 1])) or bra_cnt > ket_cnt or bra_cnt_jp > ket_cnt_jp)): t += text[i] else: sentences.append(t + text[i]) t = "" else: sentences.append(t + text[i]) return sentences結果がイマイチなときは

nの値を調節してみてください(大きいほど纏まって、小さいほどばらけます)。

括弧の数が何らかの理由でズレて文章が変に固まってしまった場合はbracketDetectをFalseにしてください。使用例

Python 3.8.5 Documentation

PDF (US-Letter paper size)\tutorial.pdf ページ番号5(p.11)より原文をコピーしたもの

CHAPTER TWO USING THE PYTHON INTERPRETER 2.1 Invoking the Interpreter The Python interpreter is usually installed as /usr/local/bin/python3.8 on those machines where it is available; putting /usr/local/bin in your Unix shell’s search path makes it possible to start it by typing the command: python3.8 to the shell.1 Since the choice of the directory where the interpreter lives is an installation option, other places are possible; check with your local Python guru or system administrator. (E.g., /usr/local/python is a popular alternative location.) On Windows machines where you have installed Python from the Microsoft Store, the python3.8 command will be available. If you have the py.exe launcher installed, you can use the py command. See setting-envvars for other ways to launch Python. Typing an end-of-file character (Control-D on Unix, Control-Z on Windows) at the primary prompt causes the interpreter to exit with a zero exit status. If that doesn’t work, you can exit the interpreter by typing the following command: quit(). The interpreter’s line-editing features include interactive editing, history substitution and code completion on systems that support the GNU Readline library. Perhaps the quickest check to see whether command line editing is supported is typing Control-P to the first Python prompt you get. If it beeps, you have command line editing; see Appendix Interactive Input Editing and History Substitution for an introduction to the keys. If nothing appears to happen, or if ^P is echoed, command line editing isn’t available; you’ll only be able to use backspace to remove characters from the current line. The interpreter operates somewhat like the Unix shell: when called with standard input connected to a tty device, it reads and executes commands interactively; when called with a file name argument or with a file as standard input, it reads and executes a script from that file. A second way of starting the interpreter is python -c command [arg] ..., which executes the statement(s) in command, analogous to the shell’s -c option. Since Python statements often contain spaces or other characters that are special to the shell, it is usually advised to quote command in its entirety with single quotes. Some Python modules are also useful as scripts. These can be invoked using python -m module [arg] ..., which executes the source file for module as if you had spelled out its full name on the command line. When a script file is used, it is sometimes useful to be able to run the script and enter interactive mode afterwards. This can be done by passing -i before the script. All command line options are described in using-on-general. 1 On Unix, the Python 3.x interpreter is by default not installed with the executable named python, so that it does not conflict with a simultaneously installed Python 2.x executable.各行末に改行コードが入っています。わかりやすいように”改行コードのまま”表示すると

CHAPTER\r\nTWO\r\nUSING THE PYTHON INTERPRETER\r\n2.1 Invoking the Interpreter\r\nThe Python interpreter is usually installed as /usr/local/bin/python3.8 on those machines where it is available;\r\nputting /usr/local/bin in your Unix shell’s search path makes it possible to start it by typing the command:\r\npython3.8\r\nto the shell.1 Since the choice of the directory where the interpreter lives is an installation option, other places are possible;\r\ncheck with your local Python guru or system administrator. (E.g., /usr/local/python is a popular alternative\r\nlocation.)\r\nOn Windows machines where you have installed Python from the Microsoft Store, the python3.8 command will be\r\navailable. If you have the py.exe launcher installed, you can use the py command. See setting-envvars for other ways to\r\nlaunch Python.\r\nTyping an end-of-file character (Control-D on Unix, Control-Z on Windows) at the primary prompt causes the\r\ninterpreter to exit with a zero exit status. If that doesn’t work, you can exit the interpreter by typing the following command:\r\nquit().\r\nThe interpreter’s line-editing features include interactive editing, history substitution and code completion on systems that\r\nsupport the GNU Readline library. Perhaps the quickest check to see whether command line editing is supported is typing\r\nControl-P to the first Python prompt you get. If it beeps, you have command line editing; see Appendix Interactive\r\nInput Editing and History Substitution for an introduction to the keys. If nothing appears to happen, or if ^P is echoed,\r\ncommand line editing isn’t available; you’ll only be able to use backspace to remove characters from the current line.\r\nThe interpreter operates somewhat like the Unix shell: when called with standard input connected to a tty device, it reads\r\nand executes commands interactively; when called with a file name argument or with a file as standard input, it reads and\r\nexecutes a script from that file.\r\nA second way of starting the interpreter is python -c command [arg] ..., which executes the statement(s) in\r\ncommand, analogous to the shell’s -c option. Since Python statements often contain spaces or other characters that are\r\nspecial to the shell, it is usually advised to quote command in its entirety with single quotes.\r\nSome Python modules are also useful as scripts. These can be invoked using python -m module [arg] ...,\r\nwhich executes the source file for module as if you had spelled out its full name on the command line.\r\nWhen a script file is used, it is sometimes useful to be able to run the script and enter interactive mode afterwards. This\r\ncan be done by passing -i before the script.\r\nAll command line options are described in using-on-general.\r\n1 On Unix, the Python 3.x interpreter is by default not installed with the executable named python, so that it does not conflict with a simultaneously\r\ninstalled Python 2.x executable.このような形になっています。

今回作った関数に投げてみます。

上の文がクリップボードにコピーされている状態を想定して、from pyperclip import paste #クリップボードから値(テキスト)を取得する関数 print("\n".join(textParser(paste())))outCHAPTER TWO USING THE PYTHON INTERPRETER 2.1 Invoking the Interpreter The Python interpreter is usually installed as /usr/local/bin/python3.8 on those machines where it is available;putting /usr/local/bin in your Unix shell’s search path makes it possible to start it by typing the command:python3.8to the shell.1 Since the choice of the directory where the interpreter lives is an installation option, other places are possible;check with your local Python guru or system administrator. (E.g., /usr/local/python is a popular alternativelocation.)On Windows machines where you have installed Python from the Microsoft Store, the python3.8 command will beavailable. If you have the py.exe launcher installed, you can use the py command. See setting-envvars for other ways tolaunch Python. Typing an end-of-file character (Control-D on Unix, Control-Z on Windows) at the primary prompt causes theinterpreter to exit with a zero exit status. If that doesn’t work, you can exit the interpreter by typing the following command:quit(). The interpreter’s line-editing features include interactive editing, history substitution and code completion on systems thatsupport the GNU Readline library. Perhaps the quickest check to see whether command line editing is supported is typingControl-P to the first Python prompt you get. If it beeps, you have command line editing; see Appendix InteractiveInput Editing and History Substitution for an introduction to the keys. If nothing appears to happen, or if ^P is echoed,command line editing isn’t available; you’ll only be able to use backspace to remove characters from the current line. The interpreter operates somewhat like the Unix shell: when called with standard input connected to a tty device, it readsand executes commands interactively; when called with a file name argument or with a file as standard input, it reads andexecutes a script from that file. A second way of starting the interpreter is python -c command [arg] ..., which executes the statement(s) incommand, analogous to the shell’s -c option. Since Python statements often contain spaces or other characters that arespecial to the shell, it is usually advised to quote command in its entirety with single quotes. Some Python modules are also useful as scripts. These can be invoked using python -m module [arg] ...,which executes the source file for module as if you had spelled out its full name on the command line. When a script file is used, it is sometimes useful to be able to run the script and enter interactive mode afterwards. Thiscan be done by passing -i before the script. installed Python 2.x executable.Pretty good!

とは言ったものの、これだけきれいなPDFをきれいに分割できるのは当然で、

もっと複雑な1カラムと2カラムを行き来するようなPDFにも使えますのでお試しあれ。まとめ

あらゆるPDFに対して完璧に整えられるわけでは決してありませんが、そこそこ使える物ができました。

日本語のPDFにも対応していますが、日本語PDFはOCRでテキストが振ってあることが結構あるのでそういう場合は.replace(" ","")などしてスペースを消してやればきれいになると思います(英文が含まれてるとこの方法は使えませんが)。

前記事のようにPDFを翻訳したいときなど、何気に使い道が多いと思うので、ぜひ使ってやってください。

- 投稿日:2020-08-12T22:23:22+09:00

【データサイエンティスト入門】Pythonの基礎♬関数とクラス

昨夜の【データサイエンティスト入門】Pythonの基礎♬関数と無名関数ほかの続きで関数とクラスの話です。

【注意】

「東京大学のデータサイエンティスト育成講座」を読んで、ちょっと疑問を持ったところや有用だと感じた部分をまとめて行こうと思う。

したがって、あらすじはまんまになると思うが内容は本書とは関係ないと思って読んでいただきたい。前振り

この章では、pythonの関数呼び出しの仕組みと,クラスの記載法と関数との違いを中心にまとめます。

関数の呼び出しの仕組みについては、以下を参考にしています。

【参考】

モジュールの関数呼び出し@PyQChapter1-2 Pythonの基礎

1-2-6 クラスとインスタンス

クラスからインスタンスを生成する。

ここでは、本書を少し離れて、関数呼び出しとクラスの宣言、そしてインスタンス実行の類似性を示すこととする。関数呼び出し

関数は、一つのPG内で利用することもあるが、複雑なPGを書こうとすると、構造的なディレクトリ構成にして、Package的に関数を保存して利用する。その場合、重要な仕組みがpythonにはある。

すなわち、以下のコードを>python calc_add.pyで実行すると以下の順番に動作する。

①二つの関数定義が行われる

②__name__にcalc_addというモデュール名が代入される

③

④if文がTrueであり、以下の二つのcalc_add.pydef calc_add(a, b): return a + b def calc_multi(a, b): return a * b print('__name__:', __name__) if __name__ == '__main__': print(calc_add(5,3)) print(calc_multi(5, 3))結果

__name__: __main__ 8 15他のコード

main.pyから実行するこの場合、

>python main.pyと実行すると

①最初の宣言文により、calc_add.pyから二つの関数calc_add, calc_multiを読み込む。このとき、出力を見ると分かるように上記のcalc_add.pyが実行され、__name__: calc_addが出力される。if文はFalse(__name__ = calc_add)なので、実行されない

②次に、main.pyのprint文が実行される

③main.pyのif文はTrueなので、以下の二つの

という仕組みで、関数呼び出しして使えるようになっている。

④というわけで、if __name__ == '__main__':という記法が入れる必要があるというわけです。しかし、呼び出して使う場合は必須ではない。main.pyfrom calc_add import calc_add, calc_multi print('__name__2:', __name__) if __name__ == '__main__': print(calc_add(5,3)) print(calc_multi(5, 3))結果

__name__: calc_add __name__2: __main__ 8 15注意)

print('__name__:', __name__)は仕組み説明のために入れているものであり、通常は必要ないclass

classも見た目、関数と同じ。

ただし、classの宣言をする。

そして、クラスはif文の中を見ると分かるように、instanceを定義してから、class内で定義した関数を呼び出して利用する。

この仕組みをオブジェクト指向と呼んでいる。

すなわち、classから多くのinstanceを生成して、それを実行させる仕組みである。

クラス定義の特徴は以下の通り。

①class宣言する

②コンストラクタdef __init__(self,x,y):を定義する。selfという変数は必須で定義する(selfという変数は特別だけど、これを単なる変数の一つなんだと思えるようになるまで少し時間がかかった)。引数xやyはその時々で必要なものを定義する。

【参考】

Pythonのselfとは?使い方や注意点について解説selfについて ・selfはinstance宣言時、引数として記述しない ・selfはクラス変数である ・クラス継承の際も使える ・クラス変数にもインスタンス変数にも値がある場合は、インスタンス変数を優先して参照③コンストラクタ

def __init__(self,x,y):はクラスのinstanceを定義した時点で、最初に動くコードである。

④その他の必要な関数を定義する。

⑤instance.calc_add()のように必要な処理を実行する

⑥if __name__ == '__main__':は、関数の時と同じ理由で書くが、呼び出して使う場合は必須ではないので、多くのクラスはこのif文や実行文が無い。

注意)print('__name__:', __name__)は仕組み説明のために入れているものであり、通常は必要ないcalc_class.pyclass MyCalcClass: def __init__(self,x,y): self.x = x self.y = y def calc_add1(self, a, b): return a + b def calc_add2(self): return self.x + self.y def calc_multi(self, a, b): return a * b print('__name__:', __name__) if __name__ == '__main__': instance_1 = MyCalcClass(1,2) instance_2 = MyCalcClass(5,10) print(instance_1.calc_add1(5,3)) print(instance_1.calc_add2()) print(instance_1.calc_multi(5, 3)) instance_1.calc_print(5)

>python calc_class.py

結果

以下の通りだが、結果はinstance1の初期値に依存して計算しているのが分かる。

if文部分を削除すると__name__: __main__のみ出力される。__name__: __main__ 8 3 15 data:5: yの値2他のコード

main.pyから実行するmain_class.pyfrom calc_class import MyCalcClass print('__name__2:', __name__) if __name__ == '__main__': instance_1 = MyCalcClass(1,2) instance_2 = MyCalcClass(5,10) print(instance_1.calc_add1(5,3)) print(instance_1.calc_add2()) print(instance_1.calc_multi(5, 3)) instance_1.calc_print(5)結果

>python main_class.py

もちろん、結果は↑と同じです。ただし、関数と同じように__name__: calc_classが出力されている。

すなわち、__name__には、呼び出したファイル名が入力され、自分自身のときは、__main__が入力される。__name__: calc_class __name__2: __main__ 8 3 15 data:5: yの値2まとめ

・関数呼び出しとクラスを比較してみた

・クラス定義して呼び出して、インスタンスを実行した・一般的なpythonコードを記述する一歩手前まで来た

・本書は、この項でpythonの基礎は終わるが、不足した部分は、今後の項で補足される(ある意味、本書はこれからもpythonの各種Libを利用してのコード解説である)

- 投稿日:2020-08-12T22:04:39+09:00

【成長日記:3日目】根尾くんのプロ初ヒットを見守るプログラムを書いてみた【NEO-METER】

根尾くん、プロ初ヒットおめでとう!

— ゆーさん (@fukannk0423) August 11, 2020

プログラムも無事に動いてくれました

NEO-METER 1 pic.twitter.com/tl05IWZVIm2018年ドラフト会議で4球団競合の末中日ドラゴンズに入団した根尾昂選手ですが、2019年の間はなかなか1軍での出番をもらえずノーヒットでシーズンを終えました。

しかし2020年は2軍での打撃成績の向上にともなって1軍に呼ばれる機会が増え、プロ初ヒットを待ちわびるファンが根尾くんの打席に注目するようになりました。

僕もそんなファンの一人です。ということで今回は、イチメーター(ICHI-METER)になぞらえて根尾くんのプロ初ヒットの瞬間を記録するためのプログラムをPythonで書きました。よかったこと

根尾くんの初ヒットまでにプログラムを完成させないといけないという制限がある中なんとか動くプログラムの作成までこぎつけることができた

悪かったこと

プログラムの中身に関してはまだまだ納得いかない要素が多く、「動きゃなんでもいい」というような付け焼刃なプログラムになってしまった

ということで、ここで振り返りたいと思います。

NEO-METER.pyの内容

基本的には、

1分ごとにスポナビの試合速報ページから根尾くんの安打数をスクレイピングするループを回して、安打数が1になったらbreakし「プロ初ヒット」のメッセージを出す

という内容のプログラムです。単純にそれだけだと根尾くんのヒットが出るまで何日でもループを続けてしまうので、ループを抜けるための条件をいくつか追加しています。

1. 試合が行われてない時(試合終了時)

2. 根尾くんが試合に出てない時

3. 240回ループを回した時以下がスクリプトです。

NEO-METER.pyimport requests import time from bs4 import BeautifulSoup import re import pandas as pd #今回はデータ処理とかしてないので使ってない neo_meter = 0 #根尾くんの安打数 count = 0 #ループした回数 endgame = False #試合終了を判断 #1分ごとにwhileループを回す while neo_meter == 0: #試合終了を判断するためにスポナビの試合ページをスクレイピングする html_eg = requests.get('https://baseball.yahoo.co.jp/npb/game/2020081102/top') soup_eg = BeautifulSoup(html_eg.content, "html.parser") ext_eg = soup_eg.select(".bb-gameCard__state") ext_eg_2 = ext_eg[0].text if '試合終了' in ext_eg_2: print('試合は終了しました') endgame = True break print('試合継続中') #ループを240回回したらbreakする if count >= 240:break #スポナビの試合ページから選手の試合成績をスクレイピングする html = requests.get('https://baseball.yahoo.co.jp/npb/game/2020081102/stats') soup = BeautifulSoup(html.content, "html.parser") ext = soup.select("td") txt = [] for i in ext: txt_temp = i.text txt.append(re.sub('\n', '', txt_temp)) #根尾くんの試合成績の部分を抜き出し、試合に出場してなかったらbreakする kensaku = '根尾' ind = [] for i,name in enumerate(txt): if kensaku in name: ind.append(i) if len(ind) == 0 :break neo = txt[ind[0]-1:ind[0]+22] ''' スポナビのページのHTMLの仕様で、 ビジターチームの打席の結果だけ、</td>が省略されているので成績表示がバグる。 NEO-METERには直接影響しないので今回はスルー ''' #根尾くんの安打数を確認しprintする #安打数が0だったらもう一度ループ、0でなかったらbreakする neo_meter = int(neo[5]) count = count + 1 print('NEO-METER', neo_meter) if neo_meter != 0:break print('終了まであと', 240 - count, '回ループを回します') time.sleep(60) #breakの条件によってメッセージを出す if neo_meter > 0: print('根尾選手、プロ初ヒット!\nN E O - M E T E R ', neo_meter-1, '→', neo_meter) else: if len(ind) == 0: print('根尾くんは今日はまだ試合に出てないみたい') elif endgame == True: print('根尾くんプロ初ヒットならず\nまた次の試合') elif count >= 240: print('240回ループを回したのでプログラムを終了します') else: print('予期せぬエラーが起きました。') exit()反省点

- ところどころバグを起こす要素が残っている

ind[]のリストの要素が2つ以上になった場合うまく成績を抜き出せない可能性- その他、主に制御文関連に自信なし

- 最初に日付を

input()で入力することでその日の中日の試合のページをスクレイピングするという機能にしたかった

- というか今日の日付から勝手にサイトをクローリングして中日の試合に飛ぶようにしたかった

- というか今日の日付自体自動で取得できる気がする

- 「只今根尾くんは打席に立っています どきどき」とか「現在相手チームの攻撃 根尾くんはセンターの守備位置についています」とかもっと状態を逐一報告させたかった

- 根尾くんがヒットを打った日を同時に表示しておいた方がのちのち振り返るときに記念日の感があってよかった

- 厳密には今日の試合の安打数のカウントをしているだけなので、ICHI-METERのように通算安打をカウントする際は改変が必要

- ループを抜けたい時にいつでも抜けられる機能を追加したかった

- プログラムが流れ作業っぽすぎてまとまりがない

- オブジェクト指向っぽいプログラムを作成できなかった

と反省する部分はたくさんありますが、とりあえず根尾くんの記念すべきプロ初ヒットを自分なりに祝うことができたので嬉しいです。今後も野球関連でおもしろそうなプログラムを書いていきたいです。

展望

「任意の選手の通算安打数をカウントする」という内容でclass化して「XXX-METER」というモジュールを作る

- 投稿日:2020-08-12T21:48:51+09:00

暇だったのでカラオケ作ってみた(第2回 ボーカル抽出と音程推定)

内容

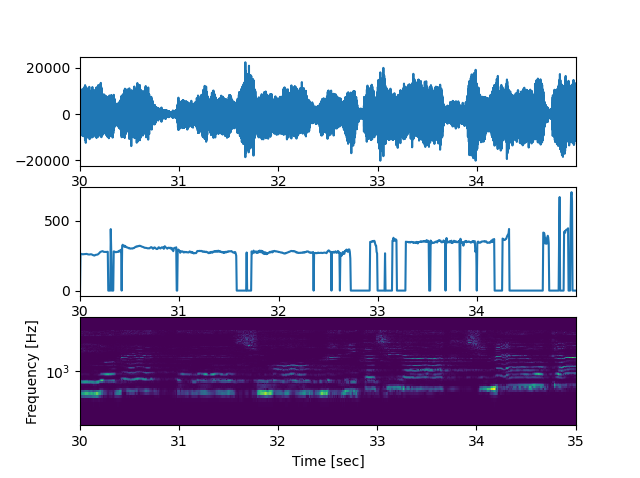

今回はspleeterで音楽ファイルからボーカルの分離とpyworldで分離したボーカルから音程(ピッチ)を推定するところを記述します。

spleeterによるボーカル分離

まず、分離したい音楽を用意してください。

今回は魔王魂様からシャイニングスターをお借りしました。

今回は ./music に test.mp3 に名前を変更して配置しています。from spleeter.separator import Separator def main(): sp = Separator("spleeter:2stems") sp.separate_to_file("music/test.mp3","music/spleeter") if __name__ == '__main__': main()とすると ./music/spleeter にtestフォルダが作成されその中にvocals.wavとaccompaniment.wavが作成されます。

music/

├ test.mp3

└ spleeter/

├ vocals.wav

└accompaniment.wav

のようになっていれば成功です。pyworldによる音程推定

公式のGitHubにf0(ピッチ)推定のやり方があるのでそれをもとに実行していきます。

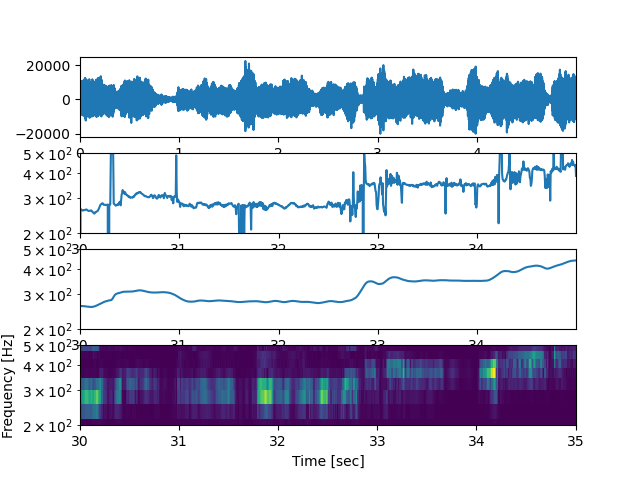

まず、波形・f0推定・スペクトログラムを見てみます。import pyworld as pw import matplotlib.pyplot as plt import numpy as np from scipy import signal from pydub import AudioSegment start = 30 #音声の抜き出し範囲 前半に無音区間があるのでそこを避けた end = 35 sound = AudioSegment.from_wav("music/spleeter/test/vocals.wav") fs = sound.frame_rate #音声はステレオなので片方を抽出する data = np.array(sound.get_array_of_samples())[start*fs*2:end*fs*2:2] data = data.astype(np.float) #音声波形の表示 t=np.arange(data.shape[0])*(data.shape[0]/fs/data.shape[0])+start plt.subplot(3,1,1) plt.plot(t,data) plt.xlim([t[0],t[-1]]) #f0推定の表示 plt.subplot(3,1,2) _f0, _time = pw.dio(data, fs) # 基本周波数の抽出 f0 = pw.stonemask(data, _f0, _time, fs) # 基本周波数の修正 t=np.arange(f0.shape[0])*(data.shape[0]/fs/f0.shape[0])+start plt.plot(t,f0) plt.xlim([t[0],t[-1]]) #スペクトログラムの表示 plt.subplot(3,1,3) f, t, Zxx = signal.stft(data, fs, nperseg=1024) plt.pcolormesh(t+start, f, np.abs(Zxx)) plt.ylim([f[1], f[-1]]) plt.ylabel('Frequency [Hz]') plt.xlabel('Time [sec]') plt.yscale('log') plt.show()これを実行すると

のような画像が作成されます。

推定はうまくいってそうですが、一部音声があるのにもかかわらず推定されていない場所がありますね。

これを改善するためにパラメータを指定してみます。

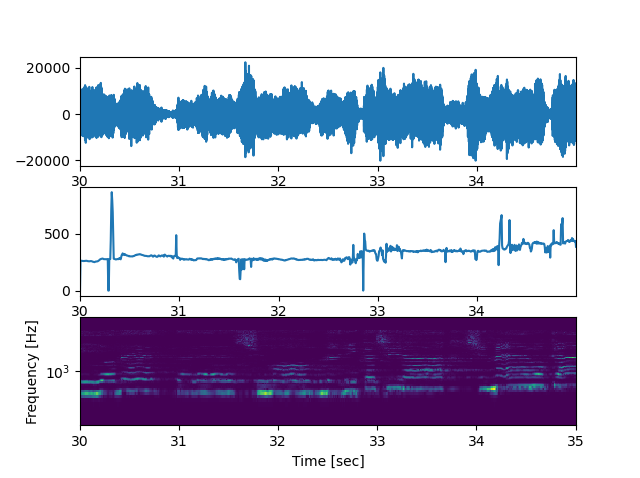

先ほどの周波数の抽出の部分を以下のように修正します。_f0, _time = pw.dio(data, fs,allowed_range=1)このように修正すると

少々外れ値がありますが、先ほどのような推定されない区間がなくなりました。

さて、次はこのグラフを外れ値を取り除いて滑らかにしたいと思います。

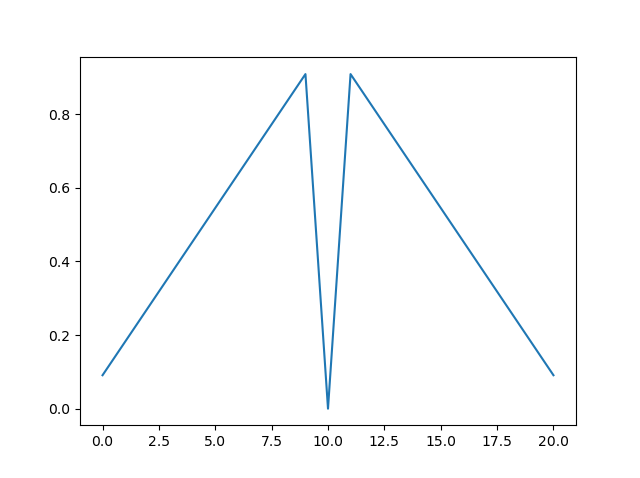

今回は畳み込み積分を利用して外れ値の推定と補正を行います。

こちらのサイトに詳しい畳み込み積分の説明があります。

異なる点として畳み込みする数列を以下のようにしています。

このようにすることで外れ値の時は畳み込み積分後の数列と元の数列で値の差に幅が生まれます。

また距離に応じて減衰させることで、近くの値の重みを重視するようにしました。

コードは以下の通りです。#畳み込み積分を行う関数 #useCenter=Falseのとき、weightの中央の値を0にする。 #つまり畳み込み積分を行うときにその値を使用しない。(外れ値推定に利用) def avg(f0,r,useCenter=False): ''' :param f0:畳み込み積分したい音程 :param r: 値を使用する半径 :param useCenter: もとの数列の値を使用するか(外れ値用) :return: 畳み込み積分後の音程 ''' weight = np.arange(2*r+3) weight = 1-np.abs(1-weight/(r+1))[1:-1] if not useCenter: weight[r]=0 arr = np.convolve(f0,weight,"same") arr_num = np.convolve(f0>0,weight,"same") arr_num[arr_num==0]=1 arr_avg = arr/arr_num return arr_avgこれを利用すると

このように外れ値の場合は周囲から推定を行うのでかなり滑らかになります。

以下にすべてのコードを示します。import pyworld as pw import matplotlib.pyplot as plt import numpy as np from scipy import signal from pydub import AudioSegment start=30 end=35 r=20 sound = AudioSegment.from_wav("music/spleetertest/test/vocals.wav") fs = sound.frame_rate data = np.array(sound.get_array_of_samples())[start*fs*2:end*fs*2:2] data = data.astype(np.float) _f0, _time = pw.dio(data, fs,allowed_range=1) # 基本周波数の抽出 f0 = pw.stonemask(data, _f0, _time, fs) # 基本周波数の修正 #畳み込み積分を行う関数 #useCenter=Falseのとき、weightの中央の値を0にする。 #つまり畳み込み積分を行うときにその値を使用しない。(外れ値推定に利用) def avg(f0,r,useCenter=False): ''' :param f0:畳み込み積分したい音程 :param r: 値を使用する半径 :param useCenter: もとの数列の値を使用するか(外れ値用) :return:畳み込み積分後の音程 ''' weight = np.arange(2*r+3) weight = 1-np.abs(1-weight/(r+1))[1:-1] if not useCenter: weight[r]=0 arr = np.convolve(f0,weight,"same") arr_num = np.convolve(f0>0,weight,"same") arr_num[arr_num==0]=1 arr_avg = arr/arr_num return arr_avg t=np.arange(data.shape[0])*(data.shape[0]/fs/data.shape[0]) plt.subplot(4,1,1) plt.plot(t,data) plt.xlim([t[0],t[-1]]) plt.subplot(4,1,2) index=np.arange(f0.shape[0]) t=np.arange(f0.shape[0])*(data.shape[0]/fs/f0.shape[0])+start plt.plot(t,f0) plt.yscale('log') plt.ylim([200, 500]) plt.xlim([t[0],t[-1]]) plt.subplot(4,1,3) f0_=avg(f0,r) br=np.abs(f0-f0_)>50 #推定との差が50Hz以上ある場合は外れ値として値を無視します f0[br]=0 f0=avg(f0,r,useCenter=True) t=np.arange(f0.shape[0])*(data.shape[0]/fs/f0.shape[0])+start plt.plot(t,f0) plt.yscale('log') plt.ylim([200, 500]) plt.xlim([t[0],t[-1]]) plt.subplot(4,1,4) f, t, Zxx = signal.stft(data, fs, nperseg=1024) plt.pcolormesh(t+start, f, np.abs(Zxx)) plt.ylim([200, 500]) plt.ylabel('Frequency [Hz]') plt.xlabel('Time [sec]') plt.yscale('log') plt.show()次回

次回は音の区切りを決めていきたいなと思います。

- 投稿日:2020-08-12T21:28:13+09:00

pythonでrequests使ってスクレイピングやろうとしたらSSLErrorでハマったので、対処法メモ

背景

題名の通り。結構ググっても、日本語でも英語でもなかなか解決方法見つからなかったので、再発時に参照できるようメモ

エラーが発生したコード

実際はwikipediaではないけど、

https://~のサイトをスクレイピングした際に発生した。

今触ってるPCだと、そのサイトが対象でもエラー出ずにスクレイピングできる。なぜだ・・・環境の問題?import requests url = 'https://ja.wikipedia.org/wiki/%E3%83%A1%E3%82%A4%E3%83%B3%E3%83%9A%E3%83%BC%E3%82%B8' response = requests.get(url) result = response.text print(result)そのときのエラーメッセージは控えられてないけど、

SSLErrorでbad handshakeという単語が含まれてたのは覚えてる対処法

verify=False作戦は使いたくなかったので色々調べ倒したところ、urllibとsslを使ったらエラー発生せずにスクレイピングできた。

ココさえ乗り越えれば、あとはBeaurifulSoup4使って欲しい要素だけ抜き出せばOKimport urllib.request import ssl url = 'https://ja.wikipedia.org/wiki/%E3%83%A1%E3%82%A4%E3%83%B3%E3%83%9A%E3%83%BC%E3%82%B8' context = ssl.SSLContext() req = urllib.request.Request(url=url) with urllib.request.urlopen(req, context=context) as f: result = f.read().decode() print(result)参考にしたサイト

- 投稿日:2020-08-12T20:45:08+09:00

【keras】noisy studentを実装して効果確認

概要

noisy studentはImagenetでSOTAをたたき出した手法です。

普通データを増やして再学習するときは人間が教師データを作る必要がありますが、noisy studentはとにかくデータを集めて現状のモデルに推論して仮の教師データとして再学習させることで精度を上げられますので、教師データの作成の時間がいらないということになります。厳密には元のラベルのいずれかに該当するデータを集めてこないといけないですが、人が教師をつける必要がないのはありがたいですね。詳しい説明は以下のサイトを参考にしてみてください。

解説: 画像認識の最新SoTAモデル「Noisy Student」を徹底解説!

論文:Self-training with Noisy Student improves ImageNet classificationやっている1つ1つはそこまで難しいことはやっていないので本記事ではimagenetを使って再現をしてみよう

と思いましたが私のPC能力では学習にとても時間がかかるのでresnet50とcifar10での実験をしてみました。

手順と実装のやり方の参考として読んでいただけると幸いです。前提

tensorflow 1.15.0

keras 2.3.1

Python 3.7.6

numpy 1.18.1

core i7

GTX1080tinoisy studentの手順

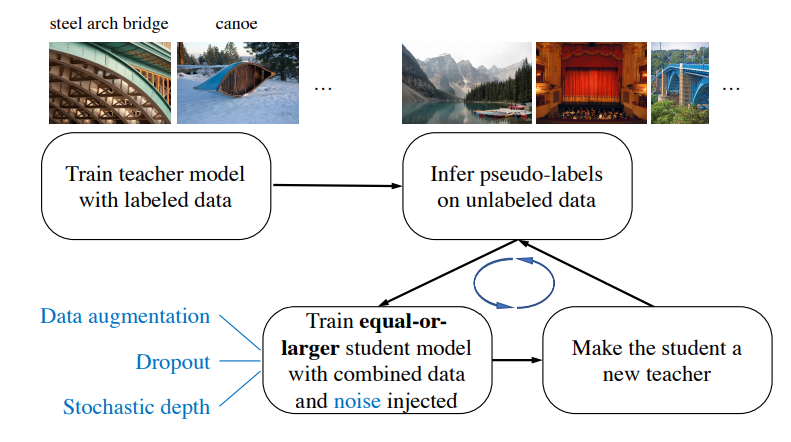

noisy studentの手順としては以下の通りになります。

引用:Self-training with Noisy Student improves ImageNet classification

日本語にしてまとめると

- 教師となるモデルをラベル有データのみで学習させる

- 教師モデルでラベルなしデータに疑似ラベルをつける

- 教師モデルと同じか大きい生徒モデルを用意する

- 生徒モデルをラベル有+疑似ラベルデータでノイズを与えて学習させる

ここでノイズとは

- Rand Augmentation→入力画像に対するノイズ

- Dropout→モデルに対するノイズ

- Stochastic depth→モデルに対するノイズ

です。

実装するにあたってそれぞれ簡単に説明しておきます。Rand Augmentation

たった2行で画像認識モデルの精度向上!?新しいDataAugmentation自動最適化手法「RandAugment」解説!

上記が解説がわかりやすいです。

要約すると、データ拡張の種類をX個準備して

- X個の中からN個取り出す

- MでAugmentationの強さを決める

以上です。簡単ですね。

noisy studentの論文ではN=2, M=27を採用しています。

今回の私の実装ではN=2, M=10としてます。

cifar10は画像サイズ小さいのであまり強くノイズをかけたら良くないかなという理由です。Dropout

これは有名なので割愛します。

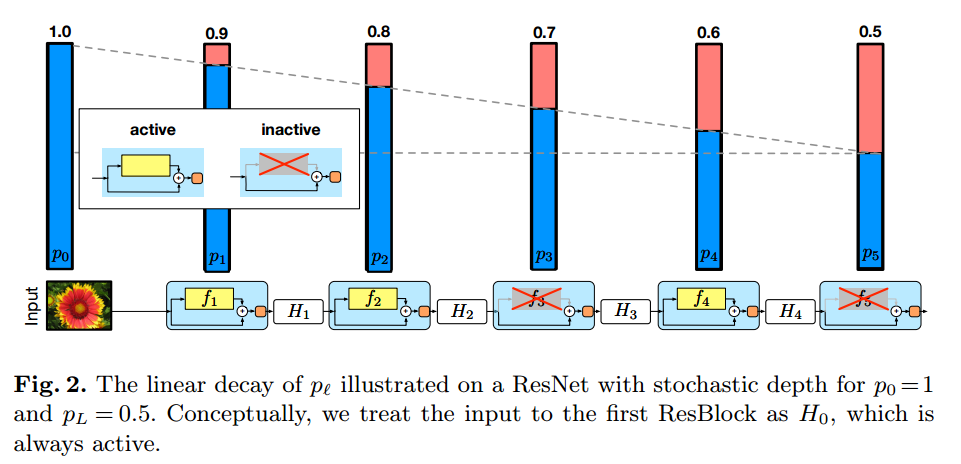

noisy studentの論文では0.5を採用しています。Stochastic depth

[Survey]Deep Networks with Stochastic Depth

詳しく知りたい方は上記の解説を参考にしてみてください。

引用:Deep Networks with Stochastic Depth上記の画像を元に簡単に説明します。

まずは基本としてはresnetの出力を確率的にスキップしている部分だけにするというものです。

そして、その確率を層が深くなるにつれて直線的に高くしていきます。

noisy studentの論文では最後の層を0.8としています。また、推論時にはその確率を各resnet blockの出力に乗算します。

実装

前段が長かったですが実装していきたいと思います。

ここで、手順をおさらいしておきます。

- 教師となるモデルをラベル有データのみで学習させる

- 教師モデルでラベルなしデータに疑似ラベルをつける

- 教師モデルと同じか大きい生徒モデルを用意する

- 生徒モデルをラベル有+疑似ラベルデータでノイズを与えて学習させる

この順番で順に実装を解説していきます。

1. 教師となるモデルをラベル有データのみで学習させる

これはよく見かけるただの分類問題です。

モデルはefficient netを準備したかったですが、実装の手間を省くためにresnet50で試しました。

注意点は基本の構造はresnet50と同じですが画像サイズが小さくなりすぎないよう

ストライドを2にする数を減らしています。データセットの準備

cifar10_resnet50.pyfrom keras.datasets import cifar10 from keras.utils.np_utils import to_categorical #cifar10のデータセットを準備 (x_train_10,y_train_10),(x_test_10,y_test_10)=cifar10.load_data() #教師データをone-hot表現に直す y_train_10 = to_categorical(y_train_10) y_test_10 = to_categorical(y_test_10)resnetのための関数準備

cifar10_resnet50.pyfrom keras.models import Model from keras.layers import Input, Activation, Dense, GlobalAveragePooling2D, Conv2D from keras import optimizers from keras.layers.normalization import BatchNormalization as BN from keras.callbacks import Callback, LearningRateScheduler, ModelCheckpoint, EarlyStopping #参考URL:https://www.pynote.info/entry/keras-resnet-implementation def shortcut_en(x, residual): '''shortcut connection を作成する。 ''' x_shape = K.int_shape(x) residual_shape = K.int_shape(residual) if x_shape == residual_shape: # x と residual の形状が同じ場合、なにもしない。 shortcut = x else: # x と residual の形状が異なる場合、線形変換を行い、形状を一致させる。 stride_w = int(round(x_shape[1] / residual_shape[1])) stride_h = int(round(x_shape[2] / residual_shape[2])) shortcut = Conv2D(filters=residual_shape[3], kernel_size=(1, 1), strides=(stride_w, stride_h), kernel_initializer='he_normal', kernel_regularizer=l2(1.e-4))(x) shortcut = BN()(shortcut) return Add()([shortcut, residual]) def normal_resblock50(data, filters, strides=1): x = Conv2D(filters=filters,kernel_size=(1,1),strides=(1,1),padding="same")(data) x = BN()(x) x = Activation("relu")(x) x = Conv2D(filters=filters,kernel_size=(3,3),strides=(1,1),padding="same")(x) x = BN()(x) x = Activation("relu")(x) x = Conv2D(filters=filters*4,kernel_size=(1,1),strides=strides,padding="same")(x) x = BN()(x) x = shortcut_en(data, x) x = Activation("relu")(x) return xresnet50実装

cifar10_resnet50.pyinputs = Input(shape = (32,32,3)) x = Conv2D(32,(5,5),padding = "SAME")(inputs) x = BN()(x) x = Activation('relu')(x) x = normal_resblock50(x, 64, 1) x = normal_resblock50(x, 64, 1) x = normal_resblock50(x, 64, 1) x = normal_resblock50(x, 128, 2) x = normal_resblock50(x, 128, 1) x = normal_resblock50(x, 128, 1) x = normal_resblock50(x, 128, 1) x = normal_resblock50(x, 256, 1) x = normal_resblock50(x, 256, 1) x = normal_resblock50(x, 256, 1) x = normal_resblock50(x, 256, 1) x = normal_resblock50(x, 256, 1) x = normal_resblock50(x, 256, 1) x = normal_resblock50(x, 512, 2) x = normal_resblock50(x, 512, 1) x = normal_resblock50(x, 512, 1) x = GlobalAveragePooling2D()(x) x = Dense(10)(x) outputs = Activation("softmax")(x) teacher_model = Model(inputs, outputs) teacher_model.summary()学習準備

cifar10_resnet50.pybatch_size = 64 steps_per_epoch = y_train_10.shape[0] // batch_size validation_steps = x_test_10.shape[0] // batch_size log_dir = 'logs/softlabel/teacher/' checkpoint = ModelCheckpoint(log_dir + 'ep{epoch:03d}-loss{loss:.3f}-val_loss{val_loss:.3f}.h5', monitor='val_loss', save_weights_only=True, save_best_only=True, period=1) reduce_lr = ReduceLROnPlateau(monitor='val_loss', factor=0.1, patience=3, verbose=1) early_stopping = EarlyStopping(monitor='val_loss', min_delta=0, patience=10, verbose=1) teacher_model.compile(loss = "categorical_crossentropy",optimizer = "adam", metrics = ["accuracy"]) trainj_gen = ImageDataGenerator(rescale = 1./255.).flow(x_train_10,y_train_10, batch_size) val_gen = ImageDataGenerator(rescale = 1./255.).flow(x_test_10,y_test_10, batch_size)学習

cifar10_resnet50.pyhistory = teacher_model.fit_generator(train_gen, initial_epoch=0, epochs=250, steps_per_epoch = steps_per_epoch, validation_data = val_gen, validation_steps = validation_steps, callbacks=[checkpoint]) history = teacher_model.fit_generator(trainj_gen, initial_epoch=250, epochs=300, steps_per_epoch = steps_per_epoch, validation_data = val_gen, validation_steps = validation_steps, callbacks=[checkpoint, reduce_lr, early_stopping])結果確認

cifar10_resnet50.py#参考URL:https://qiita.com/yy1003/items/c590d1a26918e4abe512 def my_eval(model,x,t): #model: 評価したいモデル, x: 予測する画像 shape = (batch,32,32,3) t:one-hot表現のlabel ev = model.evaluate(x,t) print("loss:" ,end = " ") print(ev[0]) print("acc: ", end = "") print(ev[1]) my_eval(teacher_model,x_test_10/255,y_test_10)teacher_eval10000/10000 [==============================] - 16s 2ms/step loss: 0.817680492834933 acc: 0.883899986743927結果はテストデータで88.39%の精度でした。

2. 教師モデルでラベルなしデータに疑似ラベルをつける

まずは疑似ラベルを付けるための画像を準備します。

少ないですが、ここではimagenetから10クラスそれぞれ約800枚ほど収集しました。

それを32×32にリサイズしたものをデータセットとしました。詳細の手順としては

- ラベルなし画像をnumpy配列にする

- ラベルなし画像に疑似ラベルをつける

- ある閾値以上の疑似ラベルデータのみを残す

- 各ラベルのデータ数を揃える

となります。

実装を載せますが3と4さえ守れば、決まったやり方はないと思いますので各々やりやすいように実装してみてください。ラベルなし画像をnumpy配列にする

imagenet_dummy_label.pyimg_path = r"D:\imagenet\cifar10\resize" img_list = os.listdir(img_path) x_train_imgnet = [] for i in img_list: abs_path = os.path.join(img_path, i) temp = load_img(abs_path) temp = img_to_array(temp) x_train_imgnet.append(temp) x_train_imgnet = np.array(x_train_imgnet)ラベルなし画像に疑似ラベルをつける

imagenet_dummy_label.py#バッチサイズの設定 batch_size = 1 #何ステップfor文を回すか step = int(x_train_imgnet.shape[0] / batch_size) print(step) #疑似ラベルのための空リスト y_train_imgnet_dummy = [] for i in range(step): #バッチサイズ分画像データを取り出す x_temp = x_train_imgnet[batch_size*i:batch_size*(i+1)] #正規化 x_temp = x_temp / 255. #推論 temp = teacher_model.predict(x_temp) #空リストへ追加 y_train_imgnet_dummy.extend(temp) #リストをnumpy配列へ y_train_imgnet_dummy = np.array(y_train_imgnet_dummy)ある閾値以上の疑似ラベルデータのみを残す

imagenet_dummy_label.py#閾値決め threhold = 0.75 y_train_imgnet_dummy_th = y_train_imgnet_dummy[np.max(y_train_imgnet_dummy, axis=1) > threhold] x_train_imgnet_th = x_train_imgnet[np.max(y_train_imgnet_dummy, axis=1) > threhold]各ラベルのデータ数を揃える

imagenet_dummy_label.py#onehot vectorから分類のインデックスにする y_student_all_dummy_label = np.argmax(y_train_imgnet_dummy_th, axis=1) #疑似ラベルの各クラスの数をカウント u, counts = np.unique(y_student_all_dummy_label, return_counts=True) print(u, counts) #カウント数の最大値を計算 student_label_max = max(counts) #numpy配列を各ラベル毎に分ける y_student_per_label = [] y_student_per_img_path = [] for i in range(10): temp_l = y_train_imgnet_dummy_th[y_student_all_dummy_label == i] print(i, ":", temp_l.shape) y_student_per_label.append(temp_l) temp_i = x_train_imgnet_th[y_student_all_dummy_label == i] print(i, ":", temp_i.shape) y_student_per_img_path.append(temp_i) #それぞれのラベルで最大のカウント数になるようにデータをコピー y_student_per_label_add = [] y_student_per_img_add = [] for i in range(10): num = y_student_per_label[i].shape[0] temp_l = y_student_per_label[i] temp_i = y_student_per_img_path[i] add_num = student_label_max - num q, mod = divmod(add_num, num) print(q, mod) temp_l_tile = np.tile(temp_l, (q+1, 1)) temp_i_tile = np.tile(temp_i, (q+1, 1, 1, 1)) temp_l_add = temp_l[:mod] temp_i_add = temp_i[:mod] y_student_per_label_add.append(np.concatenate([temp_l_tile, temp_l_add], axis=0)) y_student_per_img_add.append(np.concatenate([temp_i_tile, temp_i_add], axis=0)) #それぞれラベルのカウント数を確認 print([len(i) for i in y_student_per_label_add]) #ラベルごとのデータを合体させる student_train_img = np.concatenate(y_student_per_img_add, axis=0) student_train_label = np.concatenate(y_student_per_label_add, axis=0) #元のcifar10のnumpy配列と合体 x_train_student = np.concatenate([x_train_10, student_train_img], axis=0) y_train_student = np.concatenate([y_train_10, student_train_label], axis=0)3. 教師モデルと同じか大きい生徒モデルを用意する

ここでは教師モデルと同じサイズのresnet50で行こうと思います。

モデルのノイズとしては

- Dropout→モデルに対するノイズ

- Stochastic depth→モデルに対するノイズ

の2つです。

Stochastic depthの実装はgithubに上がっている下記の実装を参考にしました。

実装URL:https://github.com/transcranial/stochastic-depth/blob/master/stochastic-depth.ipynb私の実装では

先に各resblockでの確率のリストを作っておいて、モデルの定義の時に1つずつ取り出して使うという実装にしてます。

先に定義しておいて後で使う方がミスがなくていいかなと思ったのでそうしています。stochastic_resblock.py#各resblockの適用する確率を定義する関数 def get_p_survival(l, L, pl): pt = 1 - (l / L) * (1 - pl) return pt #確率で1か0を出力 #学習時:出力×1or0 #推論時:出力×確率 def stochastic_survival(y, p_survival=1.0): # binomial random variable survival = K.random_binomial((1,), p=p_survival) # during testing phase: # - scale y (see eq. (6)) # - p_survival effectively becomes 1 for all layers (no layer dropout) return K.in_test_phase(tf.constant(p_survival, dtype='float32') * y, survival * y) def stochastic_resblock(data, filters, strides, depth_num, p_list): print(p_list[depth_num]) x = Conv2D(filters=filters,kernel_size=(1,1),strides=(1,1),padding="same")(data) x = BN()(x) x = Activation("relu")(x) x = Conv2D(filters=filters,kernel_size=(3,3),strides=(1,1),padding="same")(x) x = BN()(x) x = Activation("relu")(x) x = Conv2D(filters=filters*4,kernel_size=(1,1),strides=strides,padding="same")(x) x = BN()(x) x = Lambda(stochastic_survival, arguments={'p_survival': p_list[depth_num]})(x) x = shortcut_en(data, x) x = Activation("relu")(x) #層の数をインクリメント depth_num += 1 return x, depth_num L = 16 pl = 0.8 p_list = [] for l in range(L+1): x = get_p_survival(l,L,pl) p_list.append(x) #0始まりだがinput layerを飛ばすために1で開始 depth_num = 1 inputs = Input(shape = (32,32,3)) x = Conv2D(32,(5,5),padding = "SAME")(inputs) x = BN()(x) x = Activation('relu')(x) #depth_numを関数内でインクリメントしながら次の層で使用 x, depth_num = stochastic_resblock(x, 64, 1, depth_num, p_list) x, depth_num = stochastic_resblock(x, 64, 1, depth_num, p_list) x, depth_num = stochastic_resblock(x, 64, 1, depth_num, p_list) x, depth_num = stochastic_resblock(x, 128, 2, depth_num, p_list) x, depth_num = stochastic_resblock(x, 128, 1, depth_num, p_list) x, depth_num = stochastic_resblock(x, 128, 1, depth_num, p_list) x, depth_num = stochastic_resblock(x, 128, 1, depth_num, p_list) x, depth_num = stochastic_resblock(x, 256, 1, depth_num, p_list) x, depth_num = stochastic_resblock(x, 256, 1, depth_num, p_list) x, depth_num = stochastic_resblock(x, 256, 1, depth_num, p_list) x, depth_num = stochastic_resblock(x, 256, 1, depth_num, p_list) x, depth_num = stochastic_resblock(x, 256, 1, depth_num, p_list) x, depth_num = stochastic_resblock(x, 256, 1, depth_num, p_list) x, depth_num = stochastic_resblock(x, 512, 2, depth_num, p_list) x, depth_num = stochastic_resblock(x, 512, 1, depth_num, p_list) x, depth_num = stochastic_resblock(x, 512, 1, depth_num, p_list) x = GlobalAveragePooling2D()(x) x = Dropout(0.5)(x) x = Dense(10)(x) outputs = Activation("softmax")(x) student_model = Model(inputs, outputs) student_model.summary() student_model.compile(loss = "categorical_crossentropy",optimizer = "adam", metrics = ["accuracy"])4. 生徒モデルをラベル有+疑似ラベルデータでノイズを与えて学習させる

データセットは2.で作成済なので、残りはRand Augmentationだけです。

githubに上がっている下記の実装を使わせていただきました。

実装URL:https://github.com/heartInsert/randaugment/blob/master/Rand_Augment.pygithubの実装はデータ形式がPILなのでnumpy配列に変換しながら教師データを出力するデータジェネレーターを自作しました。

Rand Augmentation定義

Rand_Augment.pyfrom PIL import Image import matplotlib.pyplot as plt import numpy as np from PIL import Image, ImageEnhance, ImageOps import numpy as np import random class Rand_Augment(): def __init__(self, Numbers=None, max_Magnitude=None): self.transforms = ['autocontrast', 'equalize', 'rotate', 'solarize', 'color', 'posterize', 'contrast', 'brightness', 'sharpness', 'shearX', 'shearY', 'translateX', 'translateY'] if Numbers is None: self.Numbers = len(self.transforms) // 2 else: self.Numbers = Numbers if max_Magnitude is None: self.max_Magnitude = 10 else: self.max_Magnitude = max_Magnitude fillcolor = 128 self.ranges = { # these Magnitude range , you must test it yourself , see what will happen after these operation , # it is no need to obey the value in autoaugment.py "shearX": np.linspace(0, 0.3, 10), "shearY": np.linspace(0, 0.3, 10), "translateX": np.linspace(0, 0.2, 10), "translateY": np.linspace(0, 0.2, 10), "rotate": np.linspace(0, 360, 10), "color": np.linspace(0.0, 0.9, 10), "posterize": np.round(np.linspace(8, 4, 10), 0).astype(np.int), "solarize": np.linspace(256, 231, 10), "contrast": np.linspace(0.0, 0.5, 10), "sharpness": np.linspace(0.0, 0.9, 10), "brightness": np.linspace(0.0, 0.3, 10), "autocontrast": [0] * 10, "equalize": [0] * 10, "invert": [0] * 10 } self.func = { "shearX": lambda img, magnitude: img.transform( img.size, Image.AFFINE, (1, magnitude * random.choice([-1, 1]), 0, 0, 1, 0), Image.BICUBIC, fill=fillcolor), "shearY": lambda img, magnitude: img.transform( img.size, Image.AFFINE, (1, 0, 0, magnitude * random.choice([-1, 1]), 1, 0), Image.BICUBIC, fill=fillcolor), "translateX": lambda img, magnitude: img.transform( img.size, Image.AFFINE, (1, 0, magnitude * img.size[0] * random.choice([-1, 1]), 0, 1, 0), fill=fillcolor), "translateY": lambda img, magnitude: img.transform( img.size, Image.AFFINE, (1, 0, 0, 0, 1, magnitude * img.size[1] * random.choice([-1, 1])), fill=fillcolor), "rotate": lambda img, magnitude: self.rotate_with_fill(img, magnitude), # "rotate": lambda img, magnitude: img.rotate(magnitude * random.choice([-1, 1])), "color": lambda img, magnitude: ImageEnhance.Color(img).enhance(1 + magnitude * random.choice([-1, 1])), "posterize": lambda img, magnitude: ImageOps.posterize(img, magnitude), "solarize": lambda img, magnitude: ImageOps.solarize(img, magnitude), "contrast": lambda img, magnitude: ImageEnhance.Contrast(img).enhance( 1 + magnitude * random.choice([-1, 1])), "sharpness": lambda img, magnitude: ImageEnhance.Sharpness(img).enhance( 1 + magnitude * random.choice([-1, 1])), "brightness": lambda img, magnitude: ImageEnhance.Brightness(img).enhance( 1 + magnitude * random.choice([-1, 1])), "autocontrast": lambda img, magnitude: ImageOps.autocontrast(img), "equalize": lambda img, magnitude: img, "invert": lambda img, magnitude: ImageOps.invert(img) } def rand_augment(self): """Generate a set of distortions. Args: N: Number of augmentation transformations to apply sequentially. N is len(transforms)/2 will be best M: Max_Magnitude for all the transformations. should be <= self.max_Magnitude """ M = np.random.randint(0, self.max_Magnitude, self.Numbers) sampled_ops = np.random.choice(self.transforms, self.Numbers) return [(op, Magnitude) for (op, Magnitude) in zip(sampled_ops, M)] def __call__(self, image): operations = self.rand_augment() for (op_name, M) in operations: operation = self.func[op_name] mag = self.ranges[op_name][M] image = operation(image, mag) return image def rotate_with_fill(self, img, magnitude): # I don't know why rotate must change to RGBA , it is copy from Autoaugment - pytorch rot = img.convert("RGBA").rotate(magnitude) return Image.composite(rot, Image.new("RGBA", rot.size, (128,) * 4), rot).convert(img.mode) def test_single_operation(self, image, op_name, M=-1): ''' :param image: image :param op_name: operation name in self.transforms :param M: -1 stands for the max Magnitude in there operation :return: ''' operation = self.func[op_name] mag = self.ranges[op_name][M] image = operation(image, mag) return imageデータジェネレーター定義

data_generator.pyimg_augment = Rand_Augment(Numbers=2, max_Magnitude=10) def get_random_data(x_train_i, y_train_i, data_aug): x = array_to_img(x_train_i) if data_aug: seed_image = img_augment(x) seed_image = img_to_array(seed_image) else: seed_image = x_train_i seed_image = seed_image / 255 return seed_image, y_train_i def data_generator(x_train, y_train, batch_size, data_aug): '''data generator for fit_generator''' n = len(x_train) i = 0 while True: image_data = [] label_data = [] for b in range(batch_size): if i==0: p = np.random.permutation(len(x_train)) x_train = x_train[p] y_train = y_train[p] image, label = get_random_data(x_train[i], y_train[i], data_aug) image_data.append(image) label_data.append(label) i = (i+1) % n image_data = np.array(image_data) label_data = np.array(label_data) yield image_data, label_dataデータジェネレーターができたので後は学習するだけです。

学習

data_generator.pylog_dir = 'logs/softlabel/student1_2/' checkpoint = ModelCheckpoint(log_dir + 'ep{epoch:03d}-loss{loss:.3f}-val_loss{val_loss:.3f}.h5', monitor='val_loss', save_weights_only=True, save_best_only=True, period=1) reduce_lr = ReduceLROnPlateau(monitor='val_loss', factor=0.1, patience=3, verbose=1) early_stopping = EarlyStopping(monitor='val_loss', min_delta=0, patience=10, verbose=1) batch_size = 64 steps_per_epoch = x_train_student.shape[0] // batch_size validation_steps = x_test_10.shape[0] // batch_size #0~250epochは学習率を変えずに学習 history = student_model.fit_generator(data_generator(x_train_student, y_train_student, batch_size, data_aug = True), initial_epoch=0, epochs=250, steps_per_epoch = steps_per_epoch, validation_data = data_generator_wrapper(x_test_10, y_test_10, batch_size, data_aug = False), validation_steps = validation_steps, callbacks=[checkpoint]) #250epoch~300epochは学習率を変えつつ学習の打ち止め実施 history = student_model.fit_generator(data_generator(x_train_student, y_train_student, batch_size, data_aug = True), initial_epoch=250, epochs=300, steps_per_epoch = steps_per_epoch, validation_data = data_generator_wrapper(x_test_10, y_test_10, batch_size, data_aug = False), validation_steps = validation_steps, callbacks=[checkpoint, reduce_lr, early_stopping])結果確認

eval.pymy_eval(student_model,x_test_10/255,y_test_10)student_eval10000/10000 [==============================] - 19s 2ms/step loss: 0.24697399706840514 acc: 0.9394000172615051結果はテストデータで93.94%の精度でした。

当然ですが上がっていますね。追加実験

やっていて「教師モデルの時点でノイズを有効にした場合とどちらが精度が良いか」という疑問が浮かび上がりましたので確認しました。以下の表に簡単にまとめました。

実験 教師

モデルテストデータloss/accuracy 生徒

モデルテストデータloss/accuracy 1 ノイズなし 0.8176/88.39% ノイズあり 0.2470/93.94% 2 ノイズあり 0.2492/94.14% ノイズあり 0.2289/94.28% 今回のケースだと教師からノイズを与えた方が精度が少し高くなりました。

本当はロバスト性も確認したかったのですが力尽きました。以上です。

不明点、おかしい点ありましたらコメントよろしくお願いします。

- 投稿日:2020-08-12T20:15:45+09:00

PytorchでTensorboardを使ったらエラーが出た話

はじめに

PytorchでTensorboardを使おうと思いインストールしてコードを書いて実行したらエラーに出会ったので、それの対処法を書きます。

Tensorboardのインストール

anacondaを使っているので、以下のコマンドでインストールしました。

conda install tensorboardコード

SummaryWriterでグラフを書くためにimportします。

tensorboard.pyfrom torch.utils.tensorboard import SummaryWriterエラー

下記のようなImportErrorが出ました。

ImportError: cannot import name 'SummaryWriter' from 'torch.utils.tensorboard' During handling of the above exception, another exception occurred: ImportError: TensorBoard logging requires TensorBoard with Python summary writer installed. This should be available in 1.14 or above.対処法

とりあえず、アンストして再インストール

うまくインストールができなかったのかなと思い、アンストして再びインストールしました。

同じエラーが出ました。

ここで血迷ってpipでインストールもしたりしました。(pipとcondaの混同はあまりよくない)

結局、同じエラーが出ました。Pytorchのバージョン確認

Pytorchではv1.2.0から正式にTensorboardが使えるので、とりあえずPytorchのバージョンを確認しました。

import torch print(torch.__version__)1.5.1でした。Pytorchの問題ではなさそうです。

Tensorboardのバージョン確認

エラー文には,Tensorboardのバージョンは1.14以上と書いてあるので、確認しましょう。

conda list2.2.1でした。Tensorboardの問題でもなさそうです。

ファイル名の変更

PytorchとTensorboardのバージョンを確認して大丈夫だったので、もうすることがありません。

何が原因でエラーを吐いているのかわかりません。ファイル名をみてみると、tensorboard.pyと書いてありました。

まさか、ファイル名とmoduleが衝突してimportできないことが原因なのでは?と思いました。ファイル名をtb.pyに変更しました。

そして、実行してみるとエラーが出ませんでした!!!!まとめ

PytorchでTensorboardを使おうと思いインストールしましたが、moduleとファイル名を同じにしてImportErrorが出ました。ファイル名とmoduleは別々にしましょう。

また、condaとpipの混同は避けましょう。

- 投稿日:2020-08-12T20:06:26+09:00

vscodeでpipenv使うと端末が勝手にpipenv環境内に入り込むの対処法

概要

vscodeのpython interpreterの設定がpipenv環境である場合に,vscode内の端末を開くと,勝手に

source $VENV_LOCATION/bin/activateが実行されて,pipenv環境内に入ってしまう.

それだと,.envで設定したpipenv環境内での環境変数が反映されず困る.やりたいこと

vscodeのpython interpreter設定でpipenv環境が選択されていたとしても,端末で自動的にpipenv環境がactivateされないようにする.(あとから

pipenv runなりpipenv shellを叩きたいのだ)対処法

vscodeの設定画面を開き,

python.terminal.activateEnvironmentを検索して,enableチェックを外す.

ただこれだけだったが,日本語では僕の検索能力ではヒットしなかったので,一応書いておく.

- 投稿日:2020-08-12T19:53:20+09:00

【簡単】webカメラでAI自動認識!

はじめに

webカメラでAIにより「

モノの認識」が簡単にできたら楽しいと思いませんか?

公開されているモデルを利用することで簡単にそんなことができます。

では、早速やってみましょう!具体的にどんなことをやるか

webカメラからPCに画像(映像)を取り込み、そこに写った(映った)ものは何か、AIに

リアルタイム認識させ、画面にTOP3までを表示します。今回は、学習済みモデルを利用しますので、時間のかかるAI学習などはありませんので、サクッと遊べます。

開発環境

webカメラからの画像データを取り込むために

OpenCVというライブラリとAIライブラリであるkerasを使用します。必要なライブラリのパッケージをインストールしてください。

必要なモノ 備考欄 webカメラ付きのNote PCなど PCとUSB接続によるwebカメラでもOK 開発言語 Python3.7 主な必要ライブラリ 【OpenCV】

画像や動画を処理するためのライブラリ

【keras】

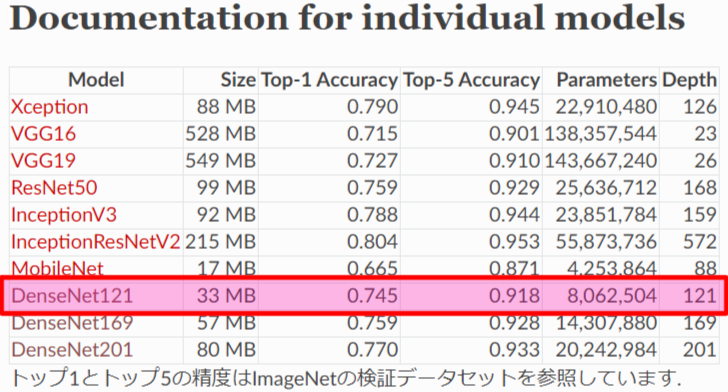

Python言語のニューラルネットワークライブラリDenseNet121

簡単って言うからやっているのに、

いきなりDenseNet121と言われて、ワケワカラン!

もうやめだ!大丈夫です。落ち着いてください。これは学習済みモデルのことで、今回は

DenseNet121という学習モデルを使用しますということです。細かいこと分からなくてもできます!

- なぜ

DenseNet121モデルに選定したのか?

kerasライブラリからVGG16、ResNet50など様々な画像分類モデルが簡単に使えるようになっていますが、その中から今回使用する画像分類モデルは、モデルサイズが33MBと比較的小さく認識率も良いためDenseNet121を選びました。「Keras Documentation」によると、DenseNet121でモノを認識させた場合、TOP5までの認識正解率が約92%となるそうです。(TOP1だけだと約75%です)

引用元:Keras Documentation

https://keras.io/ja/applications/#documentation-for-individual-modelsAIプログラム

使用するライブラリ(keras、opencv、等)のパッケージをインストールしたら、下記AIプログラムをコピペしてください。

main.py# ------------------------------------------------------------------------------------- # カメラを画面に表示する。 # DenseNet121で画像判定 # [+]キーでCameraDevice変更 # [s]キーで画像を保存する # [ESC] or [q]キーで終了 # ------------------------------------------------------------------------------------- from keras.applications.densenet import DenseNet121 from keras.applications.densenet import preprocess_input, decode_predictions from keras.preprocessing import image import numpy as np import cv2 import datetime # ------------------------------------------------------------------------------------- # capture_device # ------------------------------------------------------------------------------------- def capture_device(capture, dev): while True: # cameraデバイスから画像をキャプチャ ret, frame = capture.read() if not ret: k = ord('+') return k # DenseNet121画像判定 resize_frame = cv2.resize(frame, (300, 224)) # 640x480(4:3) -> 300x224(4:3)に画像リサイズ trim_x, trim_y = int((300-224)/2), 0 # 判定用に224x224へトリミング trim_h, trim_w = 224, 224 trim_frame = resize_frame[trim_y : (trim_y + trim_h), trim_x : (trim_x + trim_w)] x = image.img_to_array(trim_frame) x = np.expand_dims(x, axis=0) x = preprocess_input(x) preds = model.predict(x) # 画像AI判定 # Usage disp_frame = frame txt1 = "model is DenseNet121" txt2 = "camera device No.(" + str(dev) + ")" txt3 = "[+] : Change Device" txt4 = "[s] : Image Capture" txt5 = "[ESC] or [q] : Exit" cv2.putText(disp_frame, txt1, (10, 30), cv2.FONT_HERSHEY_PLAIN, 1, (255, 255, 255), 1, cv2.LINE_AA) cv2.putText(disp_frame, txt2, (10, 60), cv2.FONT_HERSHEY_PLAIN, 1, (255, 255, 255), 1, cv2.LINE_AA) cv2.putText(disp_frame, txt3, (10, 90), cv2.FONT_HERSHEY_PLAIN, 1, (255, 255, 255), 1, cv2.LINE_AA) cv2.putText(disp_frame, txt4, (10, 120), cv2.FONT_HERSHEY_PLAIN, 1, (255, 255, 255), 1, cv2.LINE_AA) cv2.putText(disp_frame, txt5, (10, 150), cv2.FONT_HERSHEY_PLAIN, 1, (255, 255, 255), 1, cv2.LINE_AA) # 画像判定文字出力 output1 = 'No.1:{0}:{1}%'.format(decode_predictions(preds, top=3)[0][0][1], int(decode_predictions(preds, top=3)[0][0][2] * 100)) output2 = 'No.2:{0}:{1}%'.format(decode_predictions(preds, top=3)[0][1][1], int(decode_predictions(preds, top=3)[0][1][2] * 100)) output3 = 'No.3:{0}:{1}%'.format(decode_predictions(preds, top=3)[0][2][1], int(decode_predictions(preds, top=3)[0][2][2] * 100)) cv2.putText(disp_frame, output1, (10, 300), cv2.FONT_HERSHEY_PLAIN, 1, (255, 255, 255), 1, cv2.LINE_AA) cv2.putText(disp_frame, output2, (10, 330), cv2.FONT_HERSHEY_PLAIN, 1, (255, 255, 255), 1, cv2.LINE_AA) cv2.putText(disp_frame, output3, (10, 360), cv2.FONT_HERSHEY_PLAIN, 1, (255, 255, 255), 1, cv2.LINE_AA) # カメラ画面出力 cv2.imshow('camera', disp_frame) # 1msec待ってキー取得 k = cv2.waitKey(1) & 0xFF # [ESC] or [q]を押されるまで画面表示し続ける if (k == ord('q')) or (k == 27): return k # [+]でdevice変更 if k == ord('+'): txt = "Change Device. Please wait... " XX = int(disp_frame.shape[1] / 4) YY = int(disp_frame.shape[0] / 2) cv2.putText(disp_frame, txt, (XX, YY), cv2.FONT_HERSHEY_PLAIN, 1, (255, 255, 255), 1, cv2.LINE_AA) cv2.imshow('camera', disp_frame) cv2.waitKey(1) & 0xFF return k # [s]で画面に表示された画像保存 elif k == ord('s'): cv2.imwrite('camera_dsp{}.{}'.format(datetime.datetime.now().strftime('%Y%m%d_%H%M%S_%f'), "png"), disp_frame) # cv2.imwrite('camera_rsz{}.{}'.format(datetime.datetime.now().strftime('%Y%m%d_%H%M%S_%f'), "png"), resize_frame) # cv2.imwrite('camera_trm{}.{}'.format(datetime.datetime.now().strftime('%Y%m%d_%H%M%S_%f'), "png"), trim_frame) # cv2.imwrite('camera_raw{}.{}'.format(datetime.datetime.now().strftime('%Y%m%d_%H%M%S_%f'), "png"), frame) # ------------------------------------------------------------------------------------- # camera # ------------------------------------------------------------------------------------- def camera(dev): while True: capture = cv2.VideoCapture(dev) ret = capture_device(capture, dev) if (ret == ord('q')) or (ret == 27): # リソース解放 capture.release() cv2.destroyAllWindows() break if ret == ord('+'): dev += 1 if dev == 9: dev = 0 # ------------------------------------------------------------------------------------- # main # ------------------------------------------------------------------------------------- # ●DenseNet121 # https://keras.io/ja/applications/#densenet # # DenseNet121を実行することで、 # (1)DenseNet121モデル、(2)クラス分類ファイルの2つが自動的にダウンロードされます。 # そのため初回起動時は約33MBあるDenseNet121モデルとクラス分類ファイルを # ダウンロードする必要があるため起動時間は長くかかりますが、 # 2回目起動時以降はダウンロードを割愛するため起動が早くなります。 # # ダウンロードファイルは以下ディレクトリに格納されます。 # 「C:/Users/xxxx/.keras/models/」 # # (1)DenseNet121のモデル:DenseNet121_weights_tf_dim_ordering_tf_kernels.h5 # (2)クラス分類ファイル(全1000分類):imagenet_class_index.json # 画像分類モデル model = DenseNet121(weights='imagenet') # カメラ起動 camera(dev=0)AIプログラム実行

初回起動時

DenseNet121ライブラリ関数を実行することで、DenseNet121モデルとクラス分類ファイルの2つが自動的にダウンロードされます。そのため初回起動時は約33MBあるDenseNet121モデルとクラス分類ファイルをダウンロードする必要があるため起動時間は長くかかりますが、2回目起動時以降はダウンロードを割愛するため起動が早くなります。ファイル格納場所

C:/Users/xxxx/.keras/models/

- DenseNet121モデル ( DenseNet121_weights_tf_dim_ordering_tf_kernels.h5 )

- クラス分類ファイル ( imagenet_class_index.json )

モデルのDLが終わると

こんな感じにwindowが開きwebカメラの映像が出力され、AIが認識したTOP3の情報が画面に表示されれば成功です。ちなみにうちのワンコ(トイプードル)を映した結果は、下記の様にAIが76%の確率でトイプードルでしょうと言っているので、AIの認識は正しいものになります。【結果の一例】AIの認識率TOP3

1. toy_poodle : 76%

2. miniature_poodle : 20%

3. Dandie_Dinmont : 1%

※リアルタイムで認識率は変動します。AIプログラム実行ログ

下記のダウンロードログは、初回のみ表示されます。

C:\Users\xxxx\anaconda3\envs\python37\python.exe C:/Users/xxxx/PycharmProjects/OpenCV/sample09.py Using TensorFlow backend. 2020-08-12 10:38:59.579123: I tensorflow/core/platform/cpu_feature_guard.cc:142] Your CPU supports instructions that this TensorFlow binary was not compiled to use: AVX AVX2 Downloading data from https://github.com/keras-team/keras-applications/releases/download/densenet/densenet121_weights_tf_dim_ordering_tf_kernels.h5 8192/33188688 [..............................] - ETA: 12:39 16384/33188688 [..............................] - ETA: 8:26 40960/33188688 [..............................] - ETA: 5:03 106496/33188688 [..............................] - ETA: 2:59 245760/33188688 [..............................] - ETA: 1:42 ~ 省略 ~ 32743424/33188688 [============================>.] - ETA: 0s 32776192/33188688 [============================>.] - ETA: 0s 32956416/33188688 [============================>.] - ETA: 0s 33005568/33188688 [============================>.] - ETA: 0s 33193984/33188688 [==============================] - 32s 1us/step Downloading data from https://storage.googleapis.com/download.tensorflow.org/data/imagenet_class_index.json 8192/35363 [=====>........................] - ETA: 0s 40960/35363 [==================================] - 0s 0us/step [ WARN:0] global C:\projects\opencv-python\opencv\modules\videoio\src\cap_msmf.cpp (436) `anonymous-namespace'::SourceReaderCB::~SourceReaderCB terminating async callback Process finished with exit code 0識別可能クラス

「

imagenet_class_index.json」ファイルを参照すると、画像が以下のNo.0~999の1000クラスに分類ができることが分かります。制限事項にもなりますが、ここに記載が無いものを認識させても、ここの中のどれかにクラス分類されてしまいます。ここに無いものを分類したい場合は、新たにモデルを作るか、転移学習、ファインチューニングなどを調べていただければと思います。imagenet_class_index.json{ "0": ["n01440764", "tench"], "1": ["n01443537", "goldfish"], "2": ["n01484850", "great_white_shark"], "3": ["n01491361", "tiger_shark"], "4": ["n01494475", "hammerhead"], "5": ["n01496331", "electric_ray"], "6": ["n01498041", "stingray"], "7": ["n01514668", "cock"], "8": ["n01514859", "hen"], "9": ["n01518878", "ostrich"], ~ 省略 ~ "990": ["n12768682", "buckeye"], "991": ["n12985857", "coral_fungus"], "992": ["n12998815", "agaric"], "993": ["n13037406", "gyromitra"], "994": ["n13040303", "stinkhorn"], "995": ["n13044778", "earthstar"], "996": ["n13052670", "hen-of-the-woods"], "997": ["n13054560", "bolete"], "998": ["n13133613", "ear"], "999": ["n15075141", "toilet_tissue"] }以上

お疲れ様でした!

- 投稿日:2020-08-12T19:06:28+09:00

Pythonでの乱数があるときのテスト

Scientific Computing with Pythonの続き

freeCodeCampでコツコツPythonを勉強しています。

前回の記事では、今回はProbability Calculatorに挑戦します。

- Python for Everybody

- Scientific Computing with Python Projects

- Arithmetic Formatter

- Time Calculator

- Budget App

- Polygon Area Calculator

- Probability Calculator(今回はここ)

5問目:Probability Calculator

今回の問題は、学生の時くらいに確率の問題で解いたことがありそうな問題。

帽子(袋)に入っている色付きボールを複数個取り出したときの確率を求める。

具体的には、

- Hatクラスの作成

- experimentメソッドの作成: 確率を求めるためのメソッド

個人的ポイント: 乱数を使ったときのテスト

今回は帽子の中からランダムにボールを取り出すという処理があります。

以下のようなテストを書きたいときにうまくいきません。1 import unittest 2 3 class UnitTests(unittest.TestCase): 4 # 赤い玉が5個、青い玉が2個入った帽子から2つボールを取り出したとき、赤い玉が1つ、青い玉が1つであること 5 def test_hat_draw(self): 6 hat = prob_calculator.Hat(red=5,blue=2) 7 actual = hat.draw(2) 8 expected = ['blue', 'red'] 9 self.assertEqual(actual, expected, 'Expected hat draw to return two random items from hat contents.') 10 actual = len(hat.contents) 11 expected = 5 12 self.assertEqual(actual, expected, 'Expected hat draw to reduce number of items in contents.')7行目で2つボールをひく時、内部の実装では乱数を使っているので、必ずしも赤い玉が1つ、青い玉が1つであるとは限らないです。

これを解決するために乱数のシードを使います。import random balls = ['red', 'red', 'red', 'red', 'red', 'blue', 'blue'] random.sample(balls, k=2) # ['red', 'red'] random.sample(balls, k=2) # ['red', 'blue'] random.seed(0) random.sample(balls, k=2) # ['blue', 'red'] random.seed(0) random.sample(balls, k=2) # ['blue', 'red']このように事前に乱数のシードを設定することによって、常に同じ挙動をさせることができます。

最後に

Scientific Computing with Pythonが一通り終わった!

次はData Analysis with Python Certificationをやり始めようと思います!

- 投稿日:2020-08-12T19:06:17+09:00

【続編】Google Earth EngineとGoogle Colabによる人工衛星画像解析 〜無料で始める衛星画像解析(実践編)〜

はじめに

- Google Earth EngineとGoogle Colabによる人工衛星画像解析 〜無料で始める衛星画像解析(入門編)〜では、Google Earth Engine (GEE)とGoogle Colabを利用した衛星画像の取得方法を紹介しました

- 本記事では、GEEで利用できる代表的な人工衛星データ(光学画像・植生指数・地表面温度)の解析方法を紹介します

- 他にも様々な衛星データセットがGEEのデータカタログには保存されており、下記コードの変数(衛星名やバンド名)を変更すれば、同様の解析が行えます

衛星データを取得するコード

- 下記のコードを利用します(コードの詳細解説は前回記事をご覧ください)

- 「衛星名」「バンド名」「データの期間」「対象エリア」「保存するフォルダ名」が変数となっており、関数を実行すると指定したフォルダ(Google Drive)に衛星画像が保存されます

関数定義

# Earth Engine Python APIのインポート import ee # GEEの認証・初期化 ee.Authenticate() ee.Initialize() # GEEのデータロード def load_data(snippet, from_date, to_date, geometry, band): # パラメータの条件にしたがってデータを抽出 dataset = ee.ImageCollection(snippet).filter( ee.Filter.date(from_date, to_date)).filter( ee.Filter.geometry(geometry)).select(band) # リスト型へ変換 data_list = dataset.toList(dataset.size().getInfo()) # 対象データ数とデータリストを出力 return dataset.size().getInfo(), data_list # 衛星画像をGoogle Driveへ保存 def save_on_gdrive(image, geometry, dir_name, file_name, scale): task = ee.batch.Export.image.toDrive(**{ 'image': image,# ロードする衛星情報 'description': file_name,# 保存するファイル名 'folder':dir_name,# 保存先のフォルダ名 'scale': scale,# 解像度 'region': geometry.getInfo()['coordinates'],# 対象エリア 'crs': 'EPSG:4326' }) # Run exporting task.start() print('Done.')変数(パラメータ)設定

## パラメーターの指定 # 衛星を指定 snippet = 'NOAA/DMSP-OLS/NIGHTTIME_LIGHTS' # バンド名を指定 band = 'avg_vis' # 期間を指定 from_date='2010-01-01' to_date='2012-12-31' # エリアを指定(日本エリアを緯度・経度を指定) geometry = ee.Geometry.Rectangle([128.60, 29.97, 148.43, 46.12]) # 保存するフォルダ名 dir_name = 'GEE_download' # ファイル名 file_name = 'file_name' # 解像度 scale = 1000処理の実行

## 処理の実行 ---------------------------------------------- num_data, data_list = load_data(snippet=snippet, from_date=from_date, to_date=to_date, geometry=geometry, band=band) print('#Datasets; ', num_data) ## 全件保存(ファイル名は衛星IDを利用) for i in range(data_list.size().getInfo()): image = ee.Image(data_list.get(i)) save_on_gdrive(image, geometry, dir_name, image.getInfo()['id'].replace('/', '_'), scale)衛星データ解析① ~光学画像~

概要

- 可視光バンド(RGB)を組み合わせて表現されるカラー画像

- 一般的に利用されている「カメラ」の写真のイメージ

- RGBのそれぞれのセンサーデータをGEEから取得して、RGB合成することで可視化できる

データセット

- 衛星 = "Sentinel 2"

- バンド = TCI_R, TCI_G, TCI_B

- 解像度: 10m

- エリア: 東京(皇居を中心)

コード

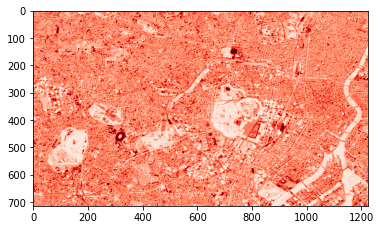

- パラメータを変更して、TCI_R(可視光の赤バンド)を取得してみます

## パラメーターの指定 # 衛星を指定 snippet = 'COPERNICUS/S2_SR' # バンド名を指定 band = 'TCI_R' # 期間を指定 from_date='2020-04-01' to_date='2020-04-15' # エリアを指定(日本エリアを緯度・経度を指定) geometry = ee.Geometry.Rectangle([139.686, 35.655, 139.796, 35.719]) # 保存するフォルダ名 dir_name = 'GEE_Sentinel_Red' # ファイル名 file_name = 'file_name' # 解像度 scale = 10 ## 処理の実行 ---------------------------------------------- num_data, data_list = load_data(snippet=snippet, from_date=from_date, to_date=to_date, geometry=geometry, band=band) print('#Datasets; ', num_data) ## 全件保存(ファイル名は衛星IDを利用) for i in range(data_list.size().getInfo()): image = ee.Image(data_list.get(i)) save_on_gdrive(image, geometry, dir_name, image.getInfo()['id'].replace('/', '_'), scale)- 次にダウンロードした衛星画像を可視化してみます

# パッケージのインストール&インポート !pip install rasterio import numpy as np import pandas as pd import matplotlib.pyplot as plt import rasterio import glob # データの読み込み with rasterio.open('/content/drive/My Drive/GEE_Sentinel_Red/COPERNICUS_S2_SR_20200402T012651_20200402T012651_T54SUE.tif') as src: arr = src.read() # 可視化 plt.imshow(arr[0], cmap='Reds')

- 中心に皇居らしきエリア、西側に代々木公園や新宿御苑が確認できます

- 次に他の緑・青バンドも取得してみます

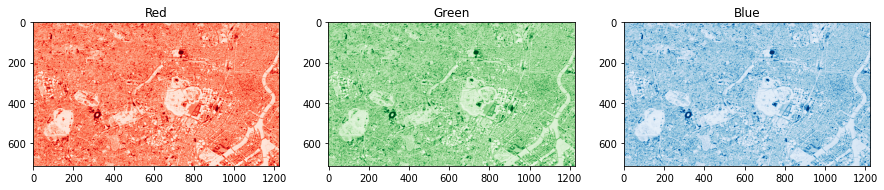

# 緑バンドのデータ取得 ## パラメーターの指定 # バンド名を指定 band = 'TCI_G' # 保存するフォルダ名 dir_name = 'GEE_Sentinel_Green' ## 処理の実行 ---------------------------------------------- num_data, data_list = load_data(snippet=snippet, from_date=from_date, to_date=to_date, geometry=geometry, band=band) print('#Datasets; ', num_data) ## 全件保存(ファイル名は衛星IDを利用) for i in range(data_list.size().getInfo()): image = ee.Image(data_list.get(i)) save_on_gdrive(image, geometry, dir_name, image.getInfo()['id'].replace('/', '_'), scale) # 青バンドのデータ取得 ## パラメーターの指定 # バンド名を指定 band = 'TCI_B' # 保存するフォルダ名 dir_name = 'GEE_Sentinel_Blue' ## 処理の実行 ---------------------------------------------- num_data, data_list = load_data(snippet=snippet, from_date=from_date, to_date=to_date, geometry=geometry, band=band) print('#Datasets; ', num_data) ## 全件保存(ファイル名は衛星IDを利用) for i in range(data_list.size().getInfo()): image = ee.Image(data_list.get(i)) save_on_gdrive(image, geometry, dir_name, image.getInfo()['id'].replace('/', '_'), scale)

- 赤バンドと同様に緑バンド、青バンドも取得することができました

- 同様にデータを読み込み可視化してみます

# データの読み込み # Red with rasterio.open('/content/drive/My Drive/GEE_Sentinel_Red/COPERNICUS_S2_SR_20200402T012651_20200402T012651_T54SUE.tif') as src: red = src.read() # Green with rasterio.open('/content/drive/My Drive/GEE_Sentinel_Green/COPERNICUS_S2_SR_20200402T012651_20200402T012651_T54SUE.tif') as src: green = src.read() # Blue with rasterio.open('/content/drive/My Drive/GEE_Sentinel_Blue/COPERNICUS_S2_SR_20200402T012651_20200402T012651_T54SUE.tif') as src: blue = src.read() # 可視化 plt.figure(figsize=(15, 10)) plt.subplot(131); plt.imshow(red[0], cmap='Reds'); plt.title('Red') plt.subplot(132); plt.imshow(green[0], cmap='Greens'); plt.title('Green') plt.subplot(133); plt.imshow(blue[0], cmap='Blues'); plt.title('Blue')

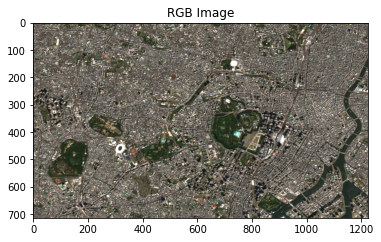

- 最後にこの3色の画像をRGB合成して、カラー画像に変換します

- RGB合成はnumpyのdstackで結合するだけです

# RGB合成 ## np.dstackで連結(Red, Green, Blueの順番に注意) rgb = np.dstack((red[0], green[0], blue[0])) # RGB合成した画像の可視化 plt.imshow(rgb); plt.title('RGB Image')

- RGB合成することで、衛星画像らしくなりました

- 今回は特定のエリア・タイミングだけで可視化を行いましたが、人工衛星が運用されている期間内であれば任意のタイミングでデータ取得が可能です

- 季節を変えてみたり、災害前後で比較したりすると色々なものが見えてきそうです(光学画像は雲の影響を受けやすいので、雨季や天気の悪い日は画像が不明瞭になることもあります)

衛星データ解析② ~植生指数~

概要

- 植物の分布や活性度を表す指標

- 植物に反応しやすい波長のセンサーを利用して計測

- 様々な植生指数が提案されているがNDVI(Normalized Difference Vegetation Index)が有名

- 砂漠化や森林火災の監視、都市利用分類などに利用されている

データセット

- 衛星 = "Terra(MODIS)"

- バンド = NDVI

- * 通常、NDVIは複数バンドを組み合わせた計算が必要なのですが、GEEでは計算済みのデータが保存されています(便利...!!)

- 解像度: 250m

- エリア: 東京(皇居を中心)

コード

- 各種パラメータを変更してNDVI(植生指数)を取得してみます

## パラメーターの指定 # 衛星を指定 snippet = 'MODIS/006/MOD13Q1' # バンド名を指定 band = 'NDVI' # 期間を指定 from_date='2005-01-01' to_date='2005-12-31' # エリアを指定(日本エリアを緯度・経度を指定) geometry = ee.Geometry.Rectangle([139.686, 35.655, 139.796, 35.719]) # 保存するフォルダ名 dir_name = 'GEE_NDVI' # 解像度 scale = 250 ## 処理の実行 ---------------------------------------------- num_data, data_list = load_data(snippet=snippet, from_date=from_date, to_date=to_date, geometry=geometry, band=band) print('#Datasets; ', num_data) ## 全件保存(ファイル名は衛星IDを利用) for i in range(data_list.size().getInfo()): image = ee.Image(data_list.get(i)) save_on_gdrive(image, geometry, dir_name, image.getInfo()['id'].replace('/', '_'), scale) ```python ## パラメーターの指定 # 衛星を指定 snippet = 'MODIS/006/MOD13Q1' # バンド名を指定 band = 'NDVI' # 期間を指定 from_date='2005-01-01' to_date='2005-12-31' # エリアを指定(日本エリアを緯度・経度を指定) geometry = ee.Geometry.Rectangle([139.686, 35.655, 139.796, 35.719]) # 保存するフォルダ名 dir_name = 'GEE_NDVI' # 解像度 scale = 250 ## 処理の実行 ---------------------------------------------- num_data, data_list = load_data(snippet=snippet, from_date=from_date, to_date=to_date, geometry=geometry, band=band) print('#Datasets; ', num_data) ## 全件保存(ファイル名は衛星IDを利用) for i in range(data_list.size().getInfo()): image = ee.Image(data_list.get(i)) save_on_gdrive(image, geometry, dir_name, image.getInfo()['id'].replace('/', '_'), scale)

- 同様に取得したデータを読み込み、可視化してみます

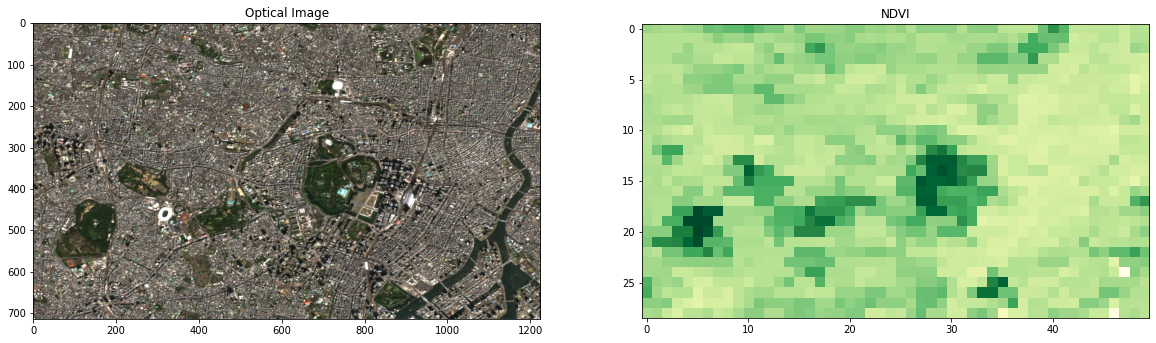

# データの読み込み with rasterio.open('/content/drive/My Drive/GEE_NDVI/MODIS_006_MOD13Q1_2005_01_01.tif') as src: arr = src.read() # 可視化 plt.figure(figsize=(20, 8)) plt.subplot(121); plt.imshow(rgb); plt.title('RGB Image'); plt.title('Optical Image') plt.subplot(122); plt.imshow(arr[0], cmap='YlGn'); plt.title('NDVI')

- 皇居や都内の公園は植生指数が高い値になっています

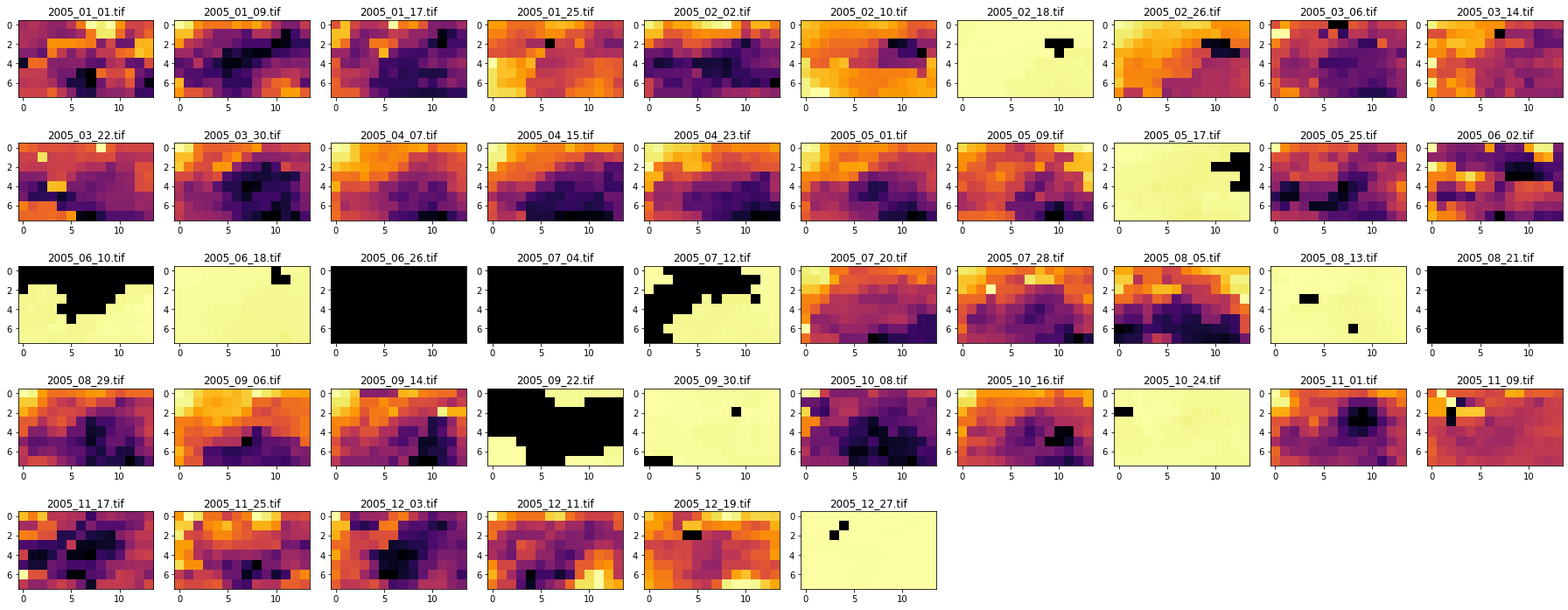

- 次に取得した期間(2005年1年間)のデータを全て可視化してみます

- 一般に植生は初夏~秋にかけて活性化し、冬には衰退するので、その様子を確認してみます

# 時系列で可視化 files = glob.glob('/content/drive/My Drive/GEE_NDVI/*tif') files.sort() plt.figure(figsize=(15, 10)) j=0 for i in range(len(files)): # 画像を1シーンずつ取得して可視化 with rasterio.open(files[i]) as src: arr = src.read() j+=1# 画像のプロット位置をシフトさせ配置 plt.subplot(5,6,j) plt.imshow(arr[0], cmap='YlGn', vmin=-2000, vmax=10000) plt.title(files[i][-14:])# ファイル名から日付を取得 plt.tight_layout()

- 5~9月頃は植生指数が活性化している様子がみてとれます

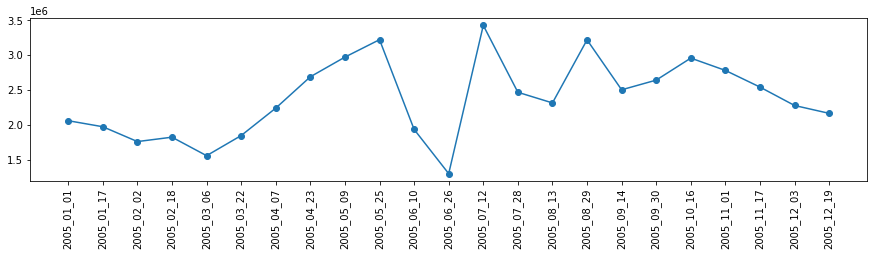

- 若干比較がしずらいので、植生指数の合計値を算出して時系列トレンドをみてみます

# 当該エリアの NDVIの数値を合計値を取得 sum_NDVI = [] label_NDVI = [] for i in range(len(files)): # 画像を1シーンずつ取得して可視化 with rasterio.open(files[i]) as src: arr = src.read() sum_NDVI.append(arr.sum()) label_NDVI.append(files[i][-14:-4]) # 可視化 fig,ax = plt.subplots(figsize=(15,3)) plt.plot(sum_NDVI, marker='o') ax.set_xticks(np.arange(0,23)) ax.set_xticklabels(label_NDVI, rotation=90) plt.show()

- 夏にかけて植生指数がピークを迎えている様子が確認できます

- 6月が大幅に現象しているのは雨季(雲)の影響で衛星が正しくデータ取得できない原因が考えられます

- 光学系の衛星は雲の影響を受けやすのが弱点ですが多様な情報を取得できる点に強みがあります(一方で雲の影響を受けないSARというタイプの衛星も存在します)

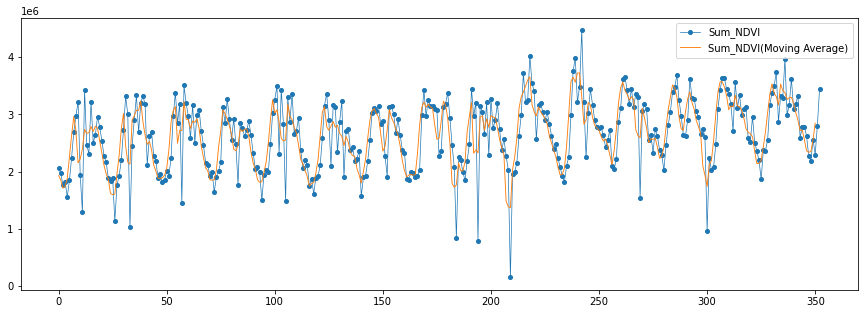

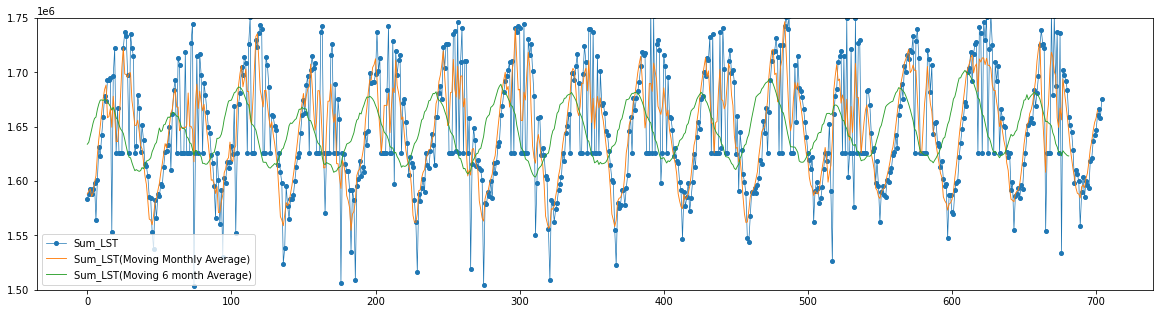

- 単年だと季節性の変化が分かりづらいので15年分のデータを取得・可視化してみました

- また移動平均も重ねて表示すると、植生指数の季節性の変化がより顕著に確認できます

衛星データ解析③ ~地表面温度~

概要

- "気温"が空気中の温度であるのに対して、"地表面温度"は地球の表面の温度を表す

- Land Surface Temperature(LST)と呼ばれる

- 人工構造物(建物や道路)は森林や土と比べて地表面度温度が高くなる傾向にある

- ヒートアイランド現象の監視等に利用されている

データセット

- 衛星 = "Terra(MODIS)"

- バンド = LST (Land Surface Temerature)

- 解像度: 1000m

- エリア: 東京(皇居を中心)

コード

- 各種パラメータを変更してLSTを取得してみます

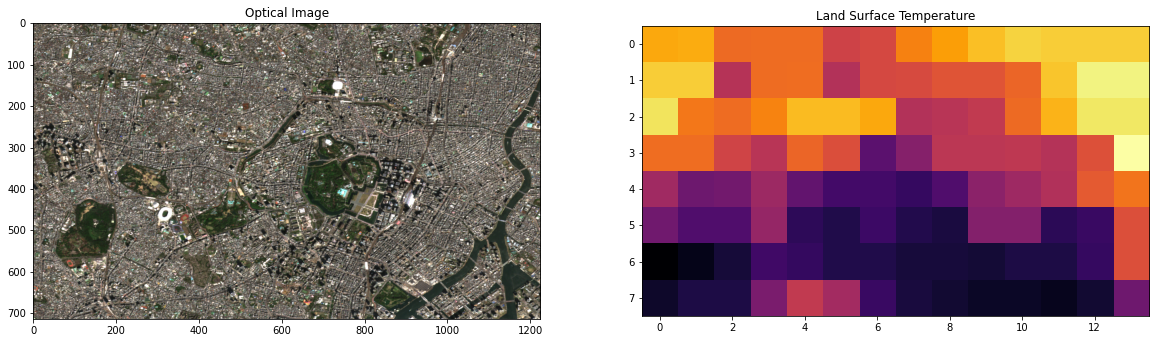

- 同様に取得したデータを可視化します

## パラメーターの指定 # 衛星を指定 snippet = 'MODIS/006/MOD11A2' # バンド名を指定 band = 'LST_Day_1km' # 期間を指定 from_date='2005-01-01' to_date='2005-12-31' # エリアを指定(日本エリアを緯度・経度を指定) geometry = ee.Geometry.Rectangle([139.686, 35.655, 139.796, 35.719]) # 保存するフォルダ名 dir_name = 'GEE_LST' # 解像度 scale = 1000 ## 処理の実行 ---------------------------------------------- num_data, data_list = load_data(snippet=snippet, from_date=from_date, to_date=to_date, geometry=geometry, band=band) print('#Datasets; ', num_data) ## 全件保存(ファイル名は衛星IDを利用) for i in range(data_list.size().getInfo()): image = ee.Image(data_list.get(i)) save_on_gdrive(image, geometry, dir_name, image.getInfo()['id'].replace('/', '_'), scale) # データの読み込み with rasterio.open('/content/drive/My Drive/GEE_LST/MODIS_006_MOD11A2_2005_08_05.tif') as src: arr = src.read() # 可視化 plt.figure(figsize=(20, 8)) plt.subplot(121); plt.imshow(rgb); plt.title('RGB Image'); plt.title('Optical Image') plt.subplot(122); plt.imshow(arr[0], cmap='inferno'); plt.title('Land Surface Temperature')東京(皇居周辺)の光学RGB画像と地表面温度

- 他データと比較して解像度が低いので若干分かりづらいです

- 該当期間を全て表示してみると、西側の方が温度が高くなる傾向にありそうです

- また地表面温度は時間解像度が高い(高頻度でデータ取得している)反面、雲の影響により正しくデータが取得できていない画像が多い点も特徴の一つです

- 植生指数と同様に長期間のデータも取得して、移動平均も含めて可視化をしてみました

- 植生と同様に季節性がありそうです(夏は高くなり、冬は低くなる)

- 解像度が低いので、もう少し広域で地表面温度を算出して、大局的なトレンドを分析した方が良さそうです

さいごに

- Google Earth EngineとGoogle Colabを用いて、代表的な衛星画像解析を紹介しました

- 上記の通りGEEとColabを利用することで、衛星名やバンド名の変数名を変更するだけで様々な衛星データの解析を行えることが分かるかと思います

- また衛星データ取得後、同一環境でPythonの便利な解析ライブラリを利用できる点が非常に便利です

- 実際の解析では、要件に応じて細かな前処理を追加したり、バイアスを除去するためにモデルを作ったりしますが、こういったサービスを利用するこで初期導入のステップは大幅に効率化できるかと思います

- また、手元の業務データをGoogle Driveへアップロードし、Colab上で衛星データとマージした解析も簡単に行えそうです

- 本記事をキッカケに様々な領域での人工衛星データ活用の一助になればと思います

- 投稿日:2020-08-12T19:03:56+09:00

Pythonのクラス継承の問題を解いてみる

Scientific Computing with Pythonの続き

freeCodeCampでコツコツPythonを勉強しています。

前回の記事では、今回はPolygon Area Calculatorに挑戦します。

- Python for Everybody

- Scientific Computing with Python Projects

- Arithmetic Formatter

- Time Calculator

- Budget App

- Polygon Area Calculator(今回はここ)

- Probability Calculator

4問目:Polygon Area Calculator

求められてることは以下の通り

- Rectangleクラスの作成

- Squareクラスの作成

rect = shape_calculator.Rectangle(10, 5) print(rect.get_area()) rect.set_height(3) print(rect.get_perimeter()) print(rect) print(rect.get_picture()) sq = shape_calculator.Square(9) print(sq.get_area()) sq.set_side(4) print(sq.get_diagonal()) print(sq) print(sq.get_picture()) rect.set_height(8) rect.set_width(16) print(rect.get_amount_inside(sq))50 26 Rectangle(width=10, height=3) ********** ********** ********** 81 5.656854249492381 Square(side=4) **** **** **** **** 8個人的ポイント: 特になし…

Rectangleの実装

class Rectangle: def __init__(self, width, height): self.width = width self.height = height def set_width(self, width): self.width = width def set_height(self, height): self.height = height def get_area(self): return self.width * self.height def get_perimeter(self): return 2 * self.width + 2 * self.height def get_diagonal(self): return (self.width ** 2 + self.height ** 2) ** .5 def get_picture(self): if(self.width >= 50 or self.height >= 50): return "Too big for picture." row = "*" * self.width return "\n".join([row for idx in range(self.height)]) + "\n" def get_amount_inside(self, shape): return int(self.get_area() / shape.get_area()) def __str__(self): return f"{self.__class__.__name__}(width={self.width}, height={self.height})"最後に

唯一調べたのは、クラス名を取得するのってどうだっけ?という部分だけでした。

成長しているのか?次の問題はProbability Calculatorです。

- 投稿日:2020-08-12T18:11:55+09:00

世界のアソビ大全51「ヨット」の役チョイスについてPythonを使って調べてみた

はじめに

https://youtu.be/iNAUzUEsgs4?t=8691

白雪巴さんが「世界のアソビ大全51」配信にて「ヨット」をプレイしていた時のこと.

「ここでチョイスはもったいない」

と言っていました.(その時の得点は20)

ふと疑問に思ったので, 少し調べてみました.

ヨットとは5つのサイコロを振って手を作るゲームであり, チョイスはその中の手の一つです.

チョイスは, すべての目の合計が得点となる役です.

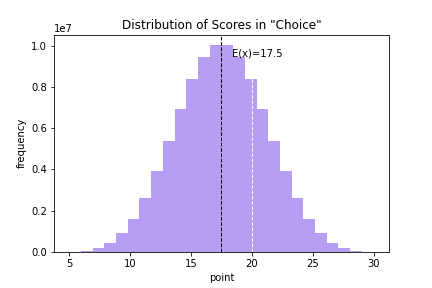

結論

20はチョイス選択「あり」

- チョイスの平均は17.5

- 20未満になる確率は 69.48%

- 21以上になる確率は 22.14%

前準備

1~6までの目がある1個のさいころを投げるとき, 出る目の数字の平均を考えます.

(※目の出方は同様に確からしいものとする)

ここで, さいころの目の合計は 21であり, それぞれの目は均等に出ることが期待できるため, もとめる平均 $E(x)$ は

$$

E(x) = \frac{1}{6} \times 21 = \frac{7}{2}

$$

と計算することが出来ます.このように求めた$E(x)$ のことを $X$ の期待値と呼び

$$

\begin{eqnarray}

E(x)

&=& x_1p_1 + x_2p_2 + \cdots + x_np_n \

&=& \sum^n_{k=1}x_kp_k\

&&(X = x_1, x_2, ..., x_n)(P=p_1, p_2, ..., p_n)

\end{eqnarray}

$$

としてもとめられる.本題

では, さいころを同時に5個投げた場合, 出た目の合計の平均を考えます.

このとき, 5個のさいころに対する確率は独立しているため, 単純に足し合わせれば求める平均を得ることが出来ます.

つまり

$$

E(x) = \frac{7}{2} \times 5 = \frac{35}{2}

$$

となります.$X$ を確率変数, $a$, $b$ を定数とするとき

$$

E(aX+b) = aE(x)+b

$$

が成り立つため, $E(X) = \frac{7}{2}$ , $a=5$, $b=0$ を代入すればもとまる実践

ここまでは数学を用いて, チョイスの平均をもとめました.

とはいえもうかなり忘れているので, 正しいかどうかわからない...ここからは Python をもちいて, もとめた平均が正しいか検証します.

なお, 以下のコードはすべて Google Colab にて動作確認しました.

平均計算

戦略は,単純.

1億回 5個のさいころを振り, その目の合計をもとめます. 次に, その平均を求めれば, もとめる平均が求まります.

つまり, 大数の法則です.

実際に試したコードが以下になります.

import numpy as np # 試行回数 N = 1 * 10**8 # チョイス実行 x = np.random.randint(1, 6+1, (N, 5)) x = x.sum(axis=1) # 平均計算 print(np.mean(x)) # 17.4996012結果は

17.4996012となり, 計算結果とほぼ一致していました.簡単に解説をば.

7行目にて, 1~6の乱数を サイズ(N, 5) で作成します.

8行目にて, 5個のさいころの合計をそれぞれ計算します.

ヒストグラム

思ったほか簡単に試せたので, おまけでヒストグラムを作成してみました.

実際に使ったコードが以下になります.

import numpy as np import matplotlib.pyplot as plt # 試行回数 N = 1 * 10**8 # チョイス実行 x = np.random.randint(1, 6+1, (N, 5)) x = x.sum(axis=1) # ヒストグラム生成 result = plt.hist(x, bins=26, alpha=0.5, color=(0.43, 0.25, 0.91)) # 補助線 ex = 17.5 min_ylim, max_ylim = plt.ylim() plt.axvline(17.5, color='k', linestyle='dashed', linewidth=1) plt.text(ex*1.05, max_ylim*0.9, f"E(x)={ex}") plt.axvline(20, color='w', linestyle='dashed', linewidth=1) # ラベル plt.title('Distribution of Scores in "Choice"') plt.xlabel("point") plt.ylabel("frequency") plt.savefig("fig.png")これにて出来たヒストグラムが以下になります.

このヒストグラムにおいて, 黒の点線が平均, 白の点線が20 となっています.

これより, 平均より超えていることが一目でわかるようになりました.

20未満の確率

さて, チョイスの得点が20未満になる確率はどれぐらいでしょうか?

これが分かれば, 説得力が増えそうです.

というわけで, Python にお願いして, 近似的に求めてみます.

import numpy as np # 試行回数 N = 1 * 10**8 # チョイス実行 x = np.random.randint(1, 6+1, (N, 5)) x = x.sum(axis=1) # 頻度計算 uni, counts = np.unique(x, return_counts=True) d = {str(u): c for u, c in zip(uni, counts)} # 20未満の発生確率 temp = [v for k, v in d.items() if int(k) < 20] print(f"{(sum(temp) / N)*100:.02f}%") # 69.48%結果は 69.48% となり, 全体の約7割が20未満となることが分かりました.

また, このプログラム 15行目にある不等号の向きを変えれば, 簡単に21以上の発生確率も調べることが出来ます.

結果は 22.14% つまり, これ以上高い手になる確率は 約2割となります.

ソシャゲのガチャに毒されているので高く感じますが... といった感じです.

おわりに

アソビ大全のゲーム 解析してみる楽しい

- 投稿日:2020-08-12T17:48:08+09:00

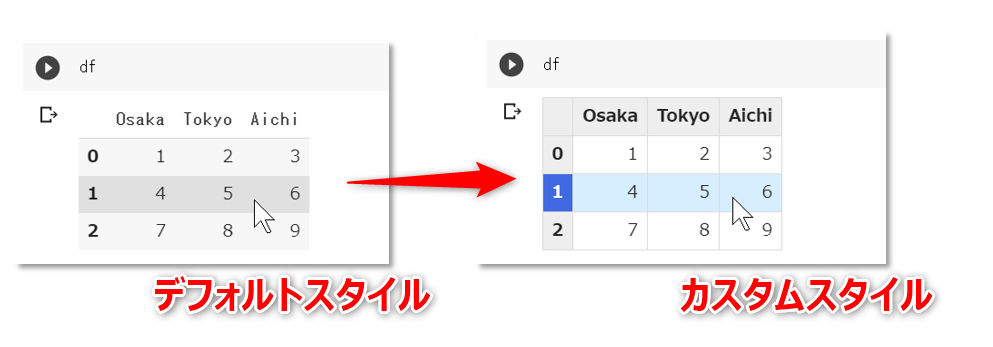

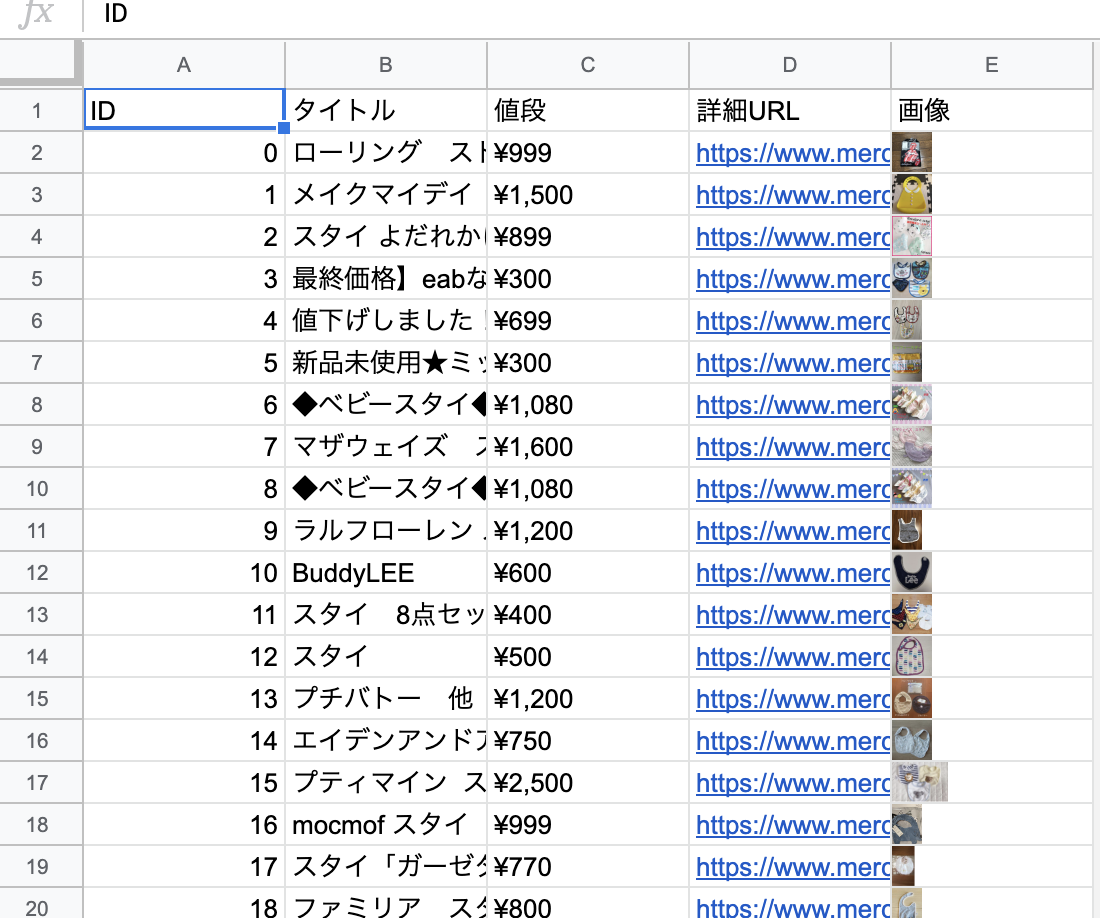

GoogleColabでdisplayにより出力されるpandasのデータフレームのデフォルトスタイル(CSS)を変更

概要

GoogleColab のなかで、IPython.display モジュールで経由で出力されるデータフレーム

pandas.DataFrameのデフォルトの見た目(スタイル/CSS)を変更するための方法です。

なお、GoogelChrome で動作確認をしています。

データフレームのスタイルを変更

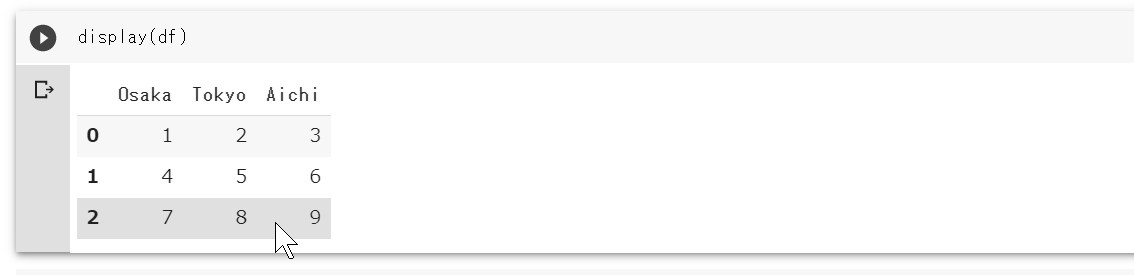

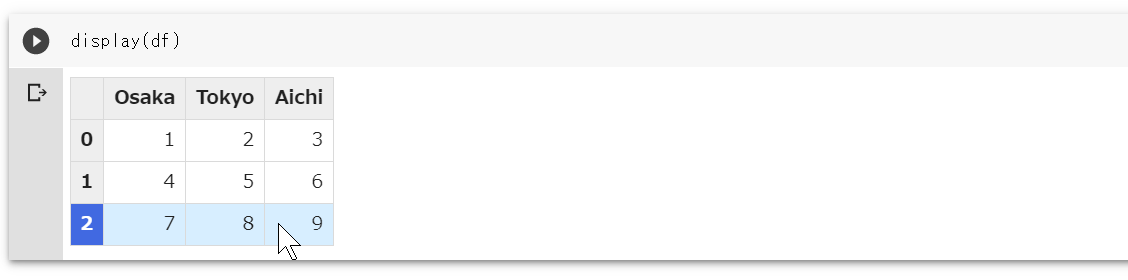

GoogleColab. のコードセルで下記を実行すると、

import pandas as pd df = pd.DataFrame([[1, 2, 3],[4, 5, 6],[7, 8, 9]], columns=['Osaka','Tokyo','Aichi']) display(df)次のようにHTMLのテーブル要素を使って整形されたデータフレームが出力されます。

このテーブルのスタイル(CSS)をカスタマイズしたい場合は、次のようなコードを挿入します。以降、

IPython.display(...)経由で出力されるデータフレーム(HTMLのテーブル要素)には、コード内で指定したCSSが適用されるようになります。データフレームの出力に適用されるCSSを変更import IPython def set_css_in_cell_output(): display(IPython.display.HTML('''<style> table.dataframe td, table.dataframe th{ border:1px solid #dadada; } table.dataframe th{ font-family: 'Roboto','Noto',sans-serif; background: #eeeeee; font-weight: bold; } table.dataframe td{ background: #ffffff; } table.dataframe tbody tr:hover th{ color: #ffffff; background-color:#4169e1; } table.dataframe tr:hover td{ background-color: #d7eeff; } </style>''')) get_ipython().events.register('pre_run_cell', set_css_in_cell_output)以降、データフレームは次のように出力されます(すべてのテーブル全体に罫線が入って、ヘッダのフォントとマウスオーバーのときの色が変わるようになりました)。

条件付き書式

セル内の数値に応じて色を変えるといった条件付き書式を適用したい場合は

DataFrame.styleを使用するようです。

- User Guide :: Styling @ pandas.pydata.org

参考資料

- How to import CSS file into Google Colab notebook (Python3) @ stackoverflow

- 投稿日:2020-08-12T17:32:04+09:00

【iOS】Pythonista3でGIFアニメ。でハマったこと。

はじめに

GIFアニメを作るアプリはたくさんありますが、せっかくPythonista3があるので、多くの先輩方の記事を参考にしながら、自分でも作ってみようと思いました。

すぐにハマる

以前にWin10上のPythonでGIFアニメを作ったことがあったので、その記憶を頼りにPILで書いたのですが、1枚目の画像しか保存されませんでした。

testGIF.pyw,h = 100,100 images = [] for c in range(0,256,8): img = Image.new('RGB',(w,h),(c,c,c)) images.append(img) images += reversed(images) SaveName = 'test.gif' images[0].save(SaveName, save_all=True, append_images=images[1:], optimize=False, duration=20, loop=0)いろいろ調べたのですが、結局win10上では動作確認ができたのでiOSのPILではうまくいかないという結論にしました。

その名も「images2gif」

調べてるうちに同様の質問があり、「images2gif」の存在を知りました。

僕のやりたかったことがそのまま名前になったようなモジュール名です。それは公式のドキュメントにも紹介されていて初めからインストールされてるものでした。

「images2gif」の使い方

基本的には次の記述でいいみたいです。

writeGif( SaveName, ImageList, duration=0.1,repeat=True)testGIF2.pyfrom PIL import Image from images2gif import writeGif w,h = 100,100 images = [] for c in range(0,256,8): img = Image.new('RGB',(w,h),(c,c,c)) images.append(img) images += reversed(images) SaveName = 'test.gif' writeGif( SaveName, images, duration=0.02,repeat=True)PythonのGIFアート

日本語ヘルプ

最後にビックリしたのは、探してたどり着いた日本語ヘルプの記事が、「以前、僕が自分で投稿したもの」で、いよいよヤバいと思いました。

- 投稿日:2020-08-12T17:14:48+09:00

[アルゴリズム×Python] 基本統計量の計算Part2(平均値、中央値、最頻値)

アルゴリズムとPythonについて書いていきます。

今回は簡単な計算を関数を使って求めるだけでなく、関数を使わない場合にどうやって求めるかについても書いていきます。目次

0.算術演算子と比較演算子の確認

1.リスト内包表記について

2.平均値を求める

2-0.算術平均

2-1.幾何平均

2-2.二乗平均

2-3.調和平均

3.中央値を求める

4.最頻値を求める

最後に0.算術演算子と比較演算子の確認

算術演算子

◯計算を行うための記号についてです。

演算子 意味 例 結果 + 足し算 3 + 4 7 - 引き算 10 - 2 8 * かけ算 5 * -6 -30 / 浮動小数点数の割り算 5 / 2 2.5 // 整数の割り算 5 // 2 2 % 割り算のあまり 7 % 2 1 ** ~乗(指数) 2 ** 4 16 比較演算子

◯比較を行うための記号についてです。

TrueかFalseのブール値を返します。

意味 演算子 等しい == 等しくない != より小さい < 以下 <= より大きい > 等しくない >= 要素になっている in ~ リスト内包表記について

◯様々な種類のリストを効率的につくるために、リスト内包表記が使われます。

今回の記事でも色々なリストを使って行きたいと思うので、事前に書いていきます。リスト内包表記とは